Автор: Яхъяева Г.Э.

Теги: типы и характеристики систем математическая логика основы математики кибернетика материалы теория множеств нейронные сети интернет информационные системы

ISBN: 5-94774-510-0

Год: 2006

ОСНОВЫ ИНФОРМАЦИОННЫХ

ТЕХНОЛОГИЙ

Г. Э. Яхъяева

НЕЧЕТКИЕ МНОЖЕСТВА И

НЕЙРОННЫЕ СЕТИ

Основы информационных технологий

Г. Э. Яхъяева

НЕЧЕТКИЕ МНОЖЕСТВА И

НЕЙРОННЫЕ СЕТИ

Учебное пособие

Интернет-Университет

Информационных Технологий

www.intuit.ru

БИНОМ.

Лаборатория знаний

www.lbz.ru

Москва

2006

УДК 004.032.26+510.6

ББК22.12+32.818

Я91

Яхъяева Г. Э.

Я91 Нечеткие множества и нейронные сети: Учебное пособие /Г. Э.

Яхъяева. — М.: Интернет-Университет Информационных Техноло-

гий; БИНОМ. Лаборатория знаний, 2006. — 316 с.: ил., табл.— (Се-

рия «Основы информационных технологий»)

ISBN 5-94774-510-0 (БИНОМ. Л3)

ISBN 5-9556-0049-3 (ИНТУИТ.РУ)

Двумя популярными направлениями Artificial Intelligence являются теория

нечетких множеств (fuzzy sets) и теория нейронных сетей (neuron nets). Данный курс

является систематизированным вводным курсом в эти два направления.

УДК 004.032.26+510.6

ББК 22.12+32.818

Издание осуществлено при финансовой и технической поддержке

издательства «Открытые Системы», «РМ Телеком» и Kraftway Computers.

Полное или частичное воспроизведение или размножение каким-либо

способом, в том числе и публикация в Сети, настоящего издания допускается

только с письменного разрешения Интсрнет-Университета

Информационных Технологий.

По вопросам приобретения обращаться:

«БИНОМ. Лаборатория знаний»

Телефон (495) 157-1902, 157-5272,

e-mail: Lbz@aha.ru, http://www.Lbz.ru

ISBN 5-94774-510-0 (БИНОМ. ЛЗ)

ISBN 5-9556-0049-3 (ИНТУИТ.РУ)

© Интернет-Университет

И нформационных

Технологий, 2006

© БИНОМ. Лаборатория

знаний, 2006

О проекте

Интернет-Университет Информационных Технологий — это первое

в России высшее учебное заведение, которое предоставляет возможность

получить дополнительное образование во Всемирной сети. Web-сайт уни-

верситета находится по адресу www.intuit.ru.

Мы рады, что вы решили расширить свои знания в области компью-

терных технологий. Современный мир — это мир компьютеров и инфор-

мации. Компьютерная индустрия — самый быстрорастущий сектор эко-

номики, и ее рост будет продолжаться еще долгое время. Во времена жест-

кой конкуренции от уровня развития информационных технологий, до-

стижений научной мысли и перспективных инженерных решений зависит

успех не только отдельных людей и компаний, но и целых стран. Вы вы-

брали самое подходящее время для изучения компьютерных дисциплин.

11рофессионалы в области информационных технологий сейчас востребо-

ваны везде: в науке, экономике, образовании, медицине и других облас-

тях, в государственных и частных компаниях, в России и за рубежом. Ана-

лиз данных, прогнозы, организация связи, создание программного обес-

печения, построение моделей процессов — вот далеко не полный список

областей применения знаний для компьютерных специалистов.

Обучение в университете ведется по собственным учебным планам,

разработанным ведущими российскими специалистами на основе между-

народных образовательных стандартов Computer Curricula 2001 Computer

Science. Изучать учебные курсы можно самостоятельно по учебникам или

па сайте Интернет-Университета, задания выполняются только на сайте.

Ддя обучения необходимо зарегистрироваться на сайте университета.

Удостоверение об окончании учебного курса или специальности выдает-

ся при условии выполнения всех заданий к лекциям и успешной сдачи

и готового экзамена.

Книга, которую вы держите в руках, — очередная в многотомной

серии «Основы информационных технологий», выпускаемой Интернет-

Университетом Информационных Технологий. В этой серии будут

выпущены учебники по всем базовым областям знаний, связанным с

компьютерными дисциплинами.

Добро пожаловать в

Интернет-Университет Информационных Технологий!

Анатолий Шкред

anatoli@shkred.ru

Об авторе

Яхъяева Гульнара Эркиновна, кандидат физико-математических на-

ук, занимается преподаванием с 1995 года. В настоящее время является

доцентом кафедры общей информатики факультета информационных

технологий Новосибирского Государственного Университета. Читает

курсы лекций «Математическая логика», «Дискретная математика» и

«Нечеткая логика». Автор 20 научных работ, регулярно принимает участие

в различных международных конференциях. Область научных интересов

— искусственный интеллект, нечеткая логика, приложения математиче-

ской логики в программировании и лингвистике.

В настоящее время занимается исследованием теоретико-модель-

ных свойств нечётких алгебраических систем, применением нечётких ал-

гебраических систем для построения формальных моделей предметных

областей и процессов обработки информации. Ряд исследовательских

проектов автора был поддержан грантами Министерства образования

Российской Федерации и Роснауки.

Оглавление

Лекция 1. Нечеткие множества как способы формализации нечет-

кости ............................................... 10

Основные определения.................................. 10

Принцип обобщения..................................... 14

Нечеткие операторы ................................... 16

Лекция 2. Нечеткие отношения............................. 19

Основные определения.................................. 19

Операции над нечеткими отношениями.................... 20

Свойства нечетких отношений........................... 22

Декомпозиция нечетких отношений................. ... 24

Транзитивное замыкание нечетких отношений............. 25

Проекции нечетких отношений........................... 26

Лекция 3. Классы нечетких отношений...................... 28

Отношения сходства и различия......................... 29

Задачи нечеткой классификации......................... 31

Порядки и слабые порядки.............................. 32

Задачи нечеткого упорядочения......................... 36

Лекция 4. Показатель размытости нечетких множеств. Нечеткие ме-

ры и интегралы....................................... 39

Аксиоматический подход к определению показателя размыто-

сти нечеткого множества............................ 40

Метрический подход к определению показателя размытости нечет-

ких множеств....................................... 41

Связь показателя размытости с алгебраическими свойствами ре-

шетки нечетких множеств............................ 42

Нечеткие меры......................................... 44

Супераддитивные меры.................................. 46

Субаддитивные меры.................................... 47

Нечеткие интегралы.................................... 49

Применение нечетких мер и интегралов для решения слабо

структурированных задач............................ 50

5

Нечеткие множества и нейронные сети

Лекция 5. Методы построения функции принадлежности. Класси-

фикация ............................................... 52

Типы шкал.............................................. 53

Методы измерений....................................... 55

Методы проведения групповой экспертизы................. 55

Классификация методов построения функции принадлежности 57

Лекция 6. М етоды построения функции принадлежности. Обзор основ-

ных методов............................................ 60

Прямые методы для одного эксперта...................... 60

Косвенные методы для одного эксперта................... 62

Прямые методы для группы экспертов..................... 65

Косвенные методы для группы экспертов.................. 66

Методы построения терм-множеств........................ 68

Лекция 7. Нечеткие числа и операции над ними.............. 71

Основные определения................................... 71

Нечеткие треугольные числа............................. 74

Четкие арифметики нечетких треугольных чисел........... 76

Размытые арифметики нечетких треугольных чисел ........ 79

Лекция 8. Нечеткая логика ................................ 82

Операции отрицания..................................... 84

Операции конъюнкции и дизъюнкции....................... 87

Лекция 9. Лингвистическая нечеткая логика.................. 91

Понятие лингвистической переменной...................... 91

Лингвистические переменные истинности.................. 95

Логические связки в нечеткой лингвистической логике.... 96

Значения истинности НЕИЗВЕСТНО и НЕ ОПРЕДЕЛЕНО . . 99

Лекция 10. Теория приближенных рассуждений.................101

Композиционное правило вывода........................... 101

Правило modus ponens как частный случай композиционного

правила вывода .....................................103

Нечеткие экспертные системы............................. 104

Лекция 11. Нечеткие алгоритмы..............................112

Формализация понятия нечеткого алгоритма................112

Способы выполнения нечетких алгоритмов..................117

Представление нечеткого алгоритма в виде графа.......... 118

6

Оглавление

Лекция 12. Нечеткие алгоритмы обучения....................120

Обучающийся нечеткий автомат.......................... 120

Обучение на основе условной нечеткой меры............. 124

Адаптивный нечеткий логический регулятор ..............126

Алгоритм формирования нечеткого отношения предпочтения 128

Алгоритм уточнения лингвистических критериев.......... 131

Лекция 13. Алгоритмы нечеткой оптимизации ................132

Нечеткие цели, ограничения и решения.................. 132

Задачи нечеткого математического программирования.....135

Модели нечеткой ожидаемой полезности...................140

Лекция 14. Алгоритмы нечеткого контроля и управления .....142

Игры в нечетко определенной обстановке . . ...........142

Многошаговые процессы принятия решений.................144

Особенности контроля и управления в условиях стохастической

неопределенности.................................. 146

Контроль и управление динамическими системами в нечетких

условиях ......................................... 147

Лекция 15. Основы искусственных нейронных сетей...........152

Биологический прототип.................................152

Искусственный нейрон.................................. 153

Однослойные искусственные нейронные сети...............156

Многослойные искусственные нейронные сети..............157

Обучение искусственных нейронных сетей............... 159

Лекция 16. Персептроны. Представимость и разделимость....162

Персептроны и зарождение искусственных нейронных сетей . . 162

Персептронная представляемость........................ 164

Проблема функции ИСКЛЮЧАЮЩЕГО ИЛИ......................165

Линейная разделимость . ...............................167

Преодоление ограничения линейной разделимости..........168

Эффективность запоминания..............................170

Лекция 17. Персептроны. Обучение персептрона..............172

Обучение персептрона...................................172

Алгоритм обучения однослойного персептрона.............173

Целочисленность весов персептронов ................... 175

Двуслойность персептрона...............................176

Трудности с алгоритмом обучения персептрона............178

7

Нечеткие множества и нейронные сети

Лекция 18. Процедура обратного распространения (описание алго-

ритма) . 180

Введение в процедуру обратного распространения.........180

Обучающий алгоритм обратного распространения...........181

Дальнейшие алгоритмические разработки..................189

Применение........................................... 190

Лекция 19. Процедура обратного распространения (анализ алгорит-

ма) ...................................................191

Переобучение и обобщение ..............................191

Отбор данных.......................................... 193

Как обучается многослойный персептрон................. 194

Предостережения........................................197

Лекция 20. Сети встречного распространения . 200

Введение в сети встречного распространения . . . . ....200

Структура сети.........................................201

Нормальное функционирование ...........................202

Обучение слоя Кохонена . ..............................203

Обучение слоя Гроссберга ..............................210

Сеть встречного распространения полностью ............211

Приложение: сжатие данных .............................212

Лекция 21. Стохастические методы обучения нейронных сетей . . 214

Использование обучения.................................214

Больцмановское обучение................................217

Обучение Коши..........................................219

Метод искусственной теплоемкости .................... 220

Обратное распространение и обучение Коши...............221

Экспериментальные результаты ..........................224

Лекция 22. Нейронные сети Хопфилда и Хэмминга.............226

Конфигурации сетей с обратными связями ................227

Бинарные системы.......................................228

Устойчивость...........................................232

Ассоциативность памяти и задача распознавания образов .... 233

Лекция 23. Обобщения и применения модели Хопфилда.........237

Модификации правила Хэбба..............................237

Алгоритмы разобучения (забывания) ... 238

Непрерывные системы....................................239

Сети Хопфилда и машина Больцмана.......................240

Приложения.............................................242

8

Оглавление

Обсуждение ............................................247

Лекция 24. Двунаправленная ассоциативная память ..........250

Структура ДАП .........................................250

Восстановление запомненных ассоциаций..................252

Кодировка ассоциаций...................................254

Емкость памяти.........................................255

Непрерывная ДАП .......................................257

Адаптивная ДАП ........................................258

Конкурирующая ДАП..................................... 258

Лекция 25. Адаптивная резонансная теория. Архитектура.....260

Принцип адаптивного резонанса..........................261

Архитектура APT .......................................263

Функционирование сети APT в процессе классификации .... 267

Лекция 26. Теория адаптивного резонанса. Реализация ......272

Функционирование сетей APT . ..........................272

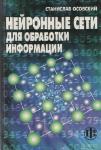

Пример обучения сети APT ............................. 276

Характеристики APT.....................................278

Дальнейшее развитие APT: архитектуры АРТ-2 и АРТ-3.....282

Лекция 27. Когнитрон......................................284

Структура сети.........................................286

Обучение когнитрона....................................287

Когнитрон как модель зрительной коры мозга.............294

Результаты моделирования...............................295

Лекция 28. Неокогнитрон...................................297

Лекция 29. Алгоритмы обучения.............................305

Обучение с учителем и без учителя......................305

Метод обучения Хэбба...................................306

Входные и выходные звезды............................ 307

Обучение персептрона...................................309

Метод обучения Уидроу—Хоффа............................311

Метод статистического обучения.........................311

Самоорганизация........................................312

9

Нечеткие множества и нейронные сети

Лекция 1. Нечеткие множества как способы

формализации нечеткости

В лекции формулируется определение нечеткого множества, описы-

ваются характеристики нечетких множеств. Приводится классификация

нечетких множеств по области значений функции принадлежности. Дает-

ся аксиоматическое описание операторов для построения алгебры нечетких

множеств.

Ключевые слова: нечеткое множество; функция принадлежности;

принцип обобщения; треугольная норма; треугольная конорма.

Основные определения

Теория нечетких множеств представляет собой обобщение и пере-

осмысление важнейших направлений классической математики. У ее ис-

токов лежат идеи и достижения многозначной логики, которая указала на

возможности перехода от двух к произвольному числу значений истинно-

сти и поставила проблему оперирования понятиями с изменяющимся со-

держанием; теории вероятностей, которая, породив большое количество

различных способов статистической обработки экспериментальных дан-

ных, открыла пути определения и интерпретации функции принадлеж-

ности; дискретной математики, которая предложила инструмент для по-

строения моделей многомерных и многоуровневых систем, удобный при

решении практических задач.

Подход к формализации понятия нечеткого множества состоит в

обобщении понятия принадлежности. В обычной теории множеств су-

ществует несколько способов задания множества. Одним из них является

задание с помощью характеристической функции, определяемой следу-

ющим образом. Пусть U — так называемое универсальное множество, из

элементов которого образованы все остальные множества, рассматрива-

емые в данном классе задач, например множество всех целых чисел, мно-

жество всех гладких функций и т. д. Характеристическая функция множе-

ства А С U — это функция р,а, значения которой указывают, является ли

х G U элементом множества А:

, . [ 1, если х € А,

(х) — < _ если т d л

I V, CVJ1J-T X t /1.

Особенностью этой функции является бинарный характер ее значе-

ний.

10

Лекция 1 Нечеткие множества как способы формализации нечеткости

С точки зрения характеристической функции, нечеткие множества

есть естественное обобщение обычных множеств, когда мы отказываем-

ся от бинарного характера этой функции и предполагаем, что она мо-

жет принимать любые значения на отрезке [0,1]. В теории нечетких мно-

жеств характеристическая функция называется функцией принадлежно-

сти, а ее значение /тд(.т) — степенью принадлежности элемента х нечет-

кому множеству А.

Более строго, нечетким множеством А называется совокупность

пар

А = {{х,рА(х)) |ж е С7},

где рА — функция принадлежности, т. е. /м -.U —» [0,1].

Пусть, например,

U = {а, Ь. с, d, е} ,

А = {(а, 0), (fe, 0,1), (с, 0,5), (d, 0,9), (е, 1)} .

Будем говорить, что элемент а не принадлежит множеству А, элемент Ь

принадлежит ему в малой степени, элемент с более или менее принадле-

жит, элемент d принадлежит в значительной степени, е является элемен-

том множества А.

Пример 1. Пусть универсум U есть мно-

жество действительных чисел. Нечеткое

множество А, обозначающее множество i

чисел, близких к 10 (см. рис. 1.1), можно

задать следующей функцией принадлеж-

ности:

0

= (1 + |ж - ЮГЕ1,

где т е N.

Показатель степени т выбирается в зависимости от степени близо-

сти к 10. Например, для описания множества чисел, очень близких к 10,

можно положить т = 4; для множества чисел, не очень далеких от 10,

т = 1.

Пример 2. Коротко остановимся на понятии лингвистической перемен-

ной (более детальное изучение будет в последующих лекциях). Лингви-

стическую переменную можно определить как переменную, значения-

ми которой являются не числа, а слова или предложения естественного

(или формального) языка. Например, лингвистическая переменная «воз-

раст» может принимать следующие значения: «очень молодой», «моло-

дой», «среднего возраста», «старый», «очень старый» и др. Ясно, что пере-

менная «возраст» будет обычной переменной, если ее значения — точные

11

Нечеткие множества и нейронные сети

числа; лингвистической она становится, будучи использованной в нечет-

ких рассуждениях человека.

Рис. 1.2

Каждому значению лингвистической пере-

менной соответствует определенное нечеткое мно-

жество со своей функцией принадлежности. Так,

лингвистическому значению «молодой» может со-

ответствовать функция принадлежности, изобра-

женная на рис. 1.2.

Над нечеткими множествами можно произ-

водить различные операции, при этом необходимо

определить их так, чтобы в частном случае, когда

множество является четким, операции переходили

в обычные операции теории множеств, то есть операции над нечеткими

множествами должны обобщать соответствующие операции над обычны-

ми множествами. При этом обобщение может быть реализовано различ-

ными способами, из-за чего какой-либо операции над обычными мно-

жествами может соответствовать несколько операций в теории нечетких

множеств.

Для определения пересечения и обзединения нечетких множеств

наибольшей популярностью пользуются следующие три группы опера-

ций:

1. Максиминные:

Р-Аив(х) = тах{рл(ж),Рв(ж)} , рдгв(-'г) = min {/м(.т),///>(.?)}

2. Алгебраические:

рдив(ж) = /м(ж) + рв(ж) - ^а(ж)/хв(ж), рдпв = рд(ж)рв(ж).

3. Ограниченные:

рдив(ж) =тт{1,дгд(я:)4-/1в(ж)},

/Мпв(ж) = тах{0,рд(ж) + MbW “ 1}

Дополнение нечеткого множества во всех трех случаях определяется

одинаково: = 1 -

Пример. Пусть А — нечеткое множество «от 5 до 8» (рис. 1.3 а) и В —

нечеткое множество «около 4» (рис. 1.36), заданные своими функциями

принадлежности:

12

Лекция 1

Нечеткие множества как способы формализации нечеткости

Рис. 1.4

Тогда, используя максиминные операции, мы получим множества,

изображенные на рис. 1.4.

Заметим, что при максиминном и алгебраическом определении опе-

раций не будут выполняться законы противоречия и исключения третье-

го АпА^0, А U Л U, а в случае ограниченных операций не будут

выполняться свойства идемпотентности Аи А А А, АпА^Ам дистри-

бутивности:

A U (В П С) ± (X П В) U (А Г) С), А П (В U С) ± (A U В) П (X U С).

Можно показать, что при любом построении операций объединения

и пересечения в теории нечетких множеств приходится отбрасывать либо

законы противоречия и исключения третьего, либо законы идемпотент-

ности и дистрибутивности.

Носителем нечеткого множества X называется четкое множество X

таких точек в U, для которых величина //д(.т) положительна, т. е. X =

= {ж|рд(а;) > 0}.

Высотой нечеткого множества X называется величина sup рд (х).

и

Нечеткое множество X называется нормальным, если sup //д(.т) = 1.

и

В противном случае оно называется субнормальным.

Нечеткое множество называется пустым, если \fx 6 U (рд (х) = 0).

13

Нечеткие множества и нейронные сети

Очевидно, что в данном универсуме U существует единственное пустое

нечеткое множество. Непустое субнормальное нечеткое множество мож-

но привести к нормальному (нормализовать) по формуле

Мд(Д =

Ра(х)

SUp Ра(х)'

и

Множеством уровня а (а-срезом) нечеткого множества А называет-

ся четкое подмножество универсального множества U, определяемое по

формуле

Аа = {ж|^д(ж) а} , где а е [0,1].

Множество строгого уровня определяется в виде Аа = {х^рА (ж) > а}.

В частности, носителем нечеткого множества является множество эле-

ментов, для которых рА (ж) > 0. Понятие множества уровня является рас-

ширением понятия интервала. Оно представляет собой объединение не

более чем счетного числа интервалов. Соответственно, алгебра интерва-

лов есть частный случай алгебры множеств уровня.

Точка перехода нечеткого множества А — это такой элемент х е U,

для которого ра (х) = 0,5.

Четкое множество А*, ближайшее к нечеткому множеству А, опре-

деляется следующим образом:

рА. (ж) = <

0, если ид (ж) < 0,5;

1, если ра (ж) > 0,5;

0 или 1, в противном случае.

Нечеткое множество А в пространстве U = Rn называется выпук-

лым нечетким множеством тогда и только тогда, если его функция при-

надлежности выпукла, т. е. для каждой пары точек ж и у из U функция

принадлежности удовлетворяет неравенству

Ид(Аа? + (1 - Х)у) min {//Дж), //ДД}, Для любого Л G [0,1].

Принцип обобщения

Принцип обобщения как одна из основных идей теории нечетких

множеств носит эвристический характер и позволяет расширить область

определения исходного отображения </? на класс нечетких множеств. Пусть

: U —» V — заданное отображение, и А — нечеткое множество, заданное

14

Лекция 1

Нечеткие множества как способы формализации нечеткости

в U. Тогда образ нечеткого множества А при отображении есть нечеткое

множество В, заданное в У с функцией принадлежности

Рв(у) = sup рд (ж).

Виды области значений функции принадлежности

Все нечеткие объекты можно классифицировать по виду области

значений функции принадлежности. Помимо интервала [0,1], функция

принадлежности может принимать свои значения в интервале [—1,1], на

числовой прямой R, а также в различных множествах, наделенных некой

структурой.

Исторически первым обобщением понятия нечеткого множества ста-

ли L-нечеткие множества, т. е. множества, у которых функции принад-

лежности принимают свои значения в конечной или бесконечной дис-

трибутивной решетке L.

Важным практическим приложением для формулировки качествен-

ных представлений и оценок человека в процессе решения задачи служит

случай S-нечетких множеств, где S — конечное линейно упорядочен-

ное множество. Например, это может быть набор значений лингвистиче-

ской переменной «КАЧЕСТВО» = {«плохое», «среднее», «хорошее», «от-

личное»}.

Гетерогенные нечеткие множества

В том случае, когда набор нечетких множеств Ai; г = 1,... ,т в U

соответствует т различным свойствам рассматриваемого объекта, каж-

дый элемент х е U характеризуется вектором значений принадлежности

(pi(a?),... ,рт(ж)), выражающим степень соответствия этим свойствам.

Таким образом, строится функция р : С7 —> [0,1]т, где [0,1]т — полная

решетка.

Дальнейшим обобщением понятия нечеткого множества является

понятие гетерогенного нечеткого множества. По признаку однородно-

сти / неоднородности области значений функции принадлежности все

описанные выше виды нечетких множеств являются гомогенными в том

смысле, что одна и та же структура области значений функции принад-

лежности берется при оценке всех элементов универсального множе-

ства U. Если же допустить, что на различных элементах универсального

множества U функция принадлежности может принимать свои значения

из различных наиболее подходящих математических структур, то мы при-

ходим к понятию гетерогенного нечеткого множества.

Гетерогенные нечеткие множества и связанные с ними составные

лингвистические переменные высокого порядка позволяют моделиро-

15

Нечеткие множества и нейронные сети

вать ситуации многокритериального принятия решения, когда имеются

признаки как с количественными, так и с порядковыми шкалами.

Нечеткие операторы

Важным вопросом использования нечетких множеств в прикладных

задачах является построение соответствующих операторов агрегирования

нечеткой информации и анализ их семантик. В теории нечетких множеств

имеется возможность применять различные операции объединения, пе-

ресечения и дополнения множеств в зависимости от контекста и ситу-

ации. Основные бинарные операции над нечеткими множествами были

описаны выше. Однако можно показать, что для любых нечетких мно-

жеств операторы F = min и G — max являются единственно возможны-

ми операторами пересечения и объединения при выполнении следующих

свойств:

1. Коммутативность:

F(pa, рв) = pa), G(pA, рв) = G(p,B, /м).

2. Ассоциативность:

F{pa,F(pb,Pc) = F(F(pa-,pb),pc),

G(pa,G(pb,Pc) = G(G(ha,Pb),pc)

3. Дистрибутивность:

F(pa, С(рв,рс) = G(F(pa,Pb),F(a,Pc)),

G(jia, F(pB,pc) = F(G(pA, Рв), GQja, hc))-

4. Монотонность:

PA < He, Рв Pd => F(pa , Рв) < F(nc. Vd), G(pA, Pb) $ G(/XC, /w)-

Pa < ив => F(/m, /м) < F{pB, рв), G(pA, pa) < G(pb, Рв)-

F(l,l) = l, G(0,0) = 0.

F(pa-Pb) < тт{ил,ив}- G(pa,Pb) > max {p.A, Рв}

С другой стороны, ясно, что жесткие, поточечно однозначные опе-

раторы недостаточно полно отражают смысл многозначных лингвисти-

ческих преобразований термов лингвистических переменных. Поэтому

большой практический интерес представляет построение обобщенных

нечетких операторов, т. е. параметризованных операторов пересечения,

16

Лекция 1 Нечеткие множества как способы формализации нечеткости

объединения, дополнения и др. Весьма общий и изящный подход к целе-

направленному формированию нечетких операторов пересечения и объ-

единения заключается в их определении в классе треугольных норм и ко-

норм.

Определение. Треугольной нормой (сокращенно t-нормой) называется

двухместная действительная функция Т : [0,1] х [0,1] —» [0,1], удовле-

творяющая следующим условиям:

1. Ограниченность: Т(0,0) — 0, Т(рд, 1) = Т(1, рд) = Ра-

2. Монотонность: рд < pc, рв Pd => Т(рд,рв) T{pc,Pd)-

3. Коммутативность: Т(рд,рв) = Т(рв,рл)-

4. Ассоциативность: Т(рд, Т(рв, рс) = Г(Г(рд, рв), рс)-

Треугольная норма Т является архимедовой, если она непрерывна и

для любого нечеткого множества рд выполнено неравенство

Т(рд, рд) < рд. Она называется строгой, если функция Т строго возрас-

тает по обоим аргументам. Примерами треугольных норм являются сле-

дующие операторы:

'I'vhpA, Рв)

7пш1п(рд, рв) min {ра, рв},

Тр^рл, рв) = Ра- Рв,

Гтах(рд, рв) = max {0, рд + рв - 1} ,

рд, если рв = 1,

рв, если рд = 1,

0 в противном случае.

Определение. Треугольной конормой (сокращенно t-конормой) называ-

ется двухместная действительная функция ± : [0,1] х [0,1] —> [0,1], удо-

влетворяющая следующим условиям:

5. Ограниченность: ±(1,1) = 1, ±(рд,0) — ±(0, рд) = Ра-

6. Монотонность: рд рс, Рв PD => -Ц.рл,рв) -L(pc, Pd)-

7. Коммутативность: -L(pa, рв) = -Ц/'в, рд).

8. Ассоциативность: ±(рд, ±(рв, рс) = -Ц-Црд, рв), рс)-

Треугольная конорма ± является архимедовой, если она непрерывна и

для любого нечеткого множества рд выполнено неравенство

±(рд, рд) > рд. Она называется строгой, если функция ± строго убывает

17

Нечеткие множества и нейронные сети

но обоим аргументам. Примерами треугольных конорм являются следу-

ющие операторы:

-Lmax(/M, Ив) = ШЙХ {jlA, Ив} ,

-Lp(pA,^в) — иа + цв — Ра Ив,

-1-т1п(ЛА,Лв) = min{l,/M + рв] ,

^-w{pa,Pb} — •

И А,

рв,

о

если ив = О,

если иа = О,

в противном случае.

В теории нелегких множеств оператор дополнения не является един-

ственным. Помимо общеизвестного Va; Д(ж) = 1— и(%), существует целый

набор операторов дополнения нечеткого множества.

Пусть задано некоторое отображение А : [0,1] —» [0,1]. Это отоб-

ражение будет называться оператором отрицания в теории нечетких мно-

жеств, если выполняются следующие условия:

(1) А(0) = 1, А(1) = О,

(2) иа < Ив => А(/гд) > А(^в).

Если кроме этого выполняются условия:

(3) А — строго убывающая функция,

(4) А — непрерывная функция,

то она называется строгим отрицанием.

Функция А называется сильным отрицанием или инволюцией, если

наряду с условиями (1)и(2) для нее справедливо:

(5) А(А(д))=д.

Приведем примеры функции отрицания:

• Классическое отрицание: А(/г) = р(к) = 1 — р(х).

• Квадратичное отрицание: А(^) = д/1 - р2.

• Отрицание Сугено: А(^л) = где — 1 < к < оо.

п х/ \ f 1, если р а,

• Дополнение порогового типа: А(н) = •{ ’ Г

у 1 ( 0, если и > а-

Будем называть любое значение А, для которого Х(р) = и, равновес-

ной точкой. Для любого непрерывного отрицания существует единствен-

ная равновесная точка.

18

Лекция 2

Нечеткие отношения

Лекция 2. Нечеткие отношения

В лекции определяется понятие нечеткого отношения, описываются

свойства нечетких отношений и операции над ними. Рассматриваются во-

просы декомпозиции и транзитивного замыкания нечетких отношений. Да-

ется определение проекции нечеткого отношения.

Ключевые слова: нечеткое отношение, транзитивное замыкание,

проекция нечеткого отношения.

Нечеткие отношения играют фундаментальную роль в теории нечет-

ких систем. Аппарат теории нечетких отношений используется при по-

строении теории нечетких автоматов, при моделировании структуры слож-

ных систем, при анализе процессов принятия решений.

Основные определения

Теория нечетких отношений находит также приложение в задачах,

в которых традиционно применяется теория обычных (четких) отноше-

ний. Как правило, аппарат теории четких отношений используется при

качественном анализе взаимосвязей между объектами исследуемой си-

стемы, когда связи носят дихотомический характер и могут быть про-

интерпретированы в терминах «связь присутствует», «связь отсутству-

ет», либо когда методы количественного анализа взаимосвязей по каким-

либо причинам неприменимым взаимосвязи искусственно приводятся к

дихотомическому виду. Например, когда величина связи между объекта-

ми принимает значения из ранговой шкалы, выбор порога на силу свя-

зи позволяет преобразовать связь к требуемому виду. Однако, подобный

подход, позволяя проводить качественный анализ систем, приводит к по-

тере информации о силе связей между объектами либо требует проведе-

ния вычислений при разных порогах на силу связей. Этого недостатка ли-

шены методы анализа данных, основанные на теории нечетких отноше-

ний, которые позволяют проводить качественный анализ систем с учетом

различия в силе связей между объектами системы.

Обычное неразмытое n-арное отношение R определяется как под-

множество декартова произведения п множеств

R С Xi х Х2 х ... х Хп.

Подобно нечеткому множеству, нечеткое отношение можно задать с

помощью его функции принадлежности

/з/г : Xi х ... х Хп -> L,

19

Нечеткие множества и нейронные сети

где в общем случае будем считать, что L — это полная дистрибутивная

решетка. Таким образом, L — это частично упорядоченное множество,

в котором любое непустое подмножество имеет наибольшую нижнюю и

наименьшую верхнюю грани и операции пересечения и объединения в L

удовлетворяют законам дистрибутивности. Все операции над нечеткими

отношениями определяются с помощью этих операций из L. Например,

если в качестве L взять ограниченное множество вещественных чисел, то

операциями пересечения и объединения в L будут, соответственно, опе-

рации min и max, и эти операции будут определять и операции над нечет-

кими отношениями.

Далее мы ограничимся рассмотрением лишь бинарных нечетких от-

ношений, являющихся отображением на отрезок [0,1], т. е. рд: X х Y —>

[0,1]-

Если множества X и Y конечны, нечеткое отношение R между X и Y

можно представить с помощью его матрицы отношения, первой строке и

первому столбцу которой ставятся в соответствие элементы множеств X

и У, а на пересечении строки х и столбца у помещается элемент у)

(см. табл. 2.1).

Таблица 2.1

У1 У2 Уз У4

Xi 0 1 0,5 0,8

•T2 0,7 0 0,6 0,3

X3 o 0,7 1 0,4

В случае, когда множества X и У совпадают, нечеткое отношение R

называют нечетким отношением на множестве X.

В случае конечных или счетных универсальных множеств очевидна

интерпретация нечеткого отношения в виде взвешенного графа, в котором

каждая пара вершин (х, у) из X х У соединяется ребром с весом R(x, у).

Пример. Пусть X = ад, х^ и У = щ, у2, уз, тогда нечеткий граф, изобра-

женный на рис 2.1, задает некоторое нечеткое отношение R с X х У.

Операции над нечеткими отношениями

Объединение и пересечение нечетких отношений определяется сле-

дующим образом:

V.t 6 X Ху G У

V.t G X Xy G У

R U S (t, y) = R(x, у) V S(x, y),

RnS (x,y) = R(x, у) Л S(x,y)

20

Лекция 2

Нечеткие отношения

Рис. 2.1.

Отношение включения R С S для нечетких отношений определяется

с помощью отношения частичного порядка на L;

VxtXVyeY RQS &.R(x,y)^S(x,y).

Множество р (X х Y) всех нечетких отношений между X и Y образу-

ет дистрибутивную решетку по отношению к операциям объединения и

пересечения и удовлетворяет следующим тождествам:

]. Идемпотентность:

R(~]R = R,

2. Коммутативность-

R П S = S О R,

3. Ассоциативность:

Rn(SQT) = (RKS)riT,

4. Дистрибутивность:

Rn(SUT) = (RAS)U(RnT),

R U R = R.

RUS = SUR.

RU(SUT) = (RUJS)UT.

R U (S П T) = (R U S) П (R U T)

Выполнение этих тождеств для р (X xY) следует из выполнения со-

ответствующих тождеств для решетки L. В р (X х Y) выполняется также

следующее соотношение:

SCT => RuSQRuT. RQS = RnT.

Из полноты решетки L следует, что она обладает наименьшим 0 и

наибольшим I элементами. Эти элементы определяют, соответственно,

пустое и универсальное нечеткие отношения:

V.t \/у ©(х, у) — 0, V.tV?/ U(х, у) = I.

21

Нечеткие множества и нейронные сети

Следующее соотношение определяет композицию Ro S нечетких от-

ношений R и S:

УхеХХ/zeZ RoS(x,z) = V (R(x,y) R S(y,z)).

yEY

Здесь V обозначает наименьшую верхнюю грань множества эле-

ysY

ментов (R(x, у) A S(y, z)), где у пробегает все значения из Y. В силу пол-

ноты L эта операция всегда определена.

Существуют и другие варианты операции композиции, которые

определяются с помощью дополнительных операций, выводимых в L.

В зависимости от того, является ли L множеством векторов, множеством

лингвистических переменных или множеством чисел, эти дополнитель-

ные операции будут иметь соответствующий вид. Например, если L яв-

ляется множеством действительных чисел, то операция А может быть за-

менена на операцию взятия среднего арифметического, что дает другое

определение операции композиции:

VxeXVzeZ R о S(x,y) = у (0,5(R(x,y) + S(y,z))).

y<=Y

В случае L = [0,1] мы имеем

Vx G X Vz е Z /zhos(t,z) = У (1лк(х,у) /\p.s(x,y)).

ееУ

Замена операции А на операцию умножения дает следующее опре-

деление композиции: Vt € XVz 6 Z рдод(я;, z) = V (jj.r(x, у)-[1з(х,уУ)-

ее И

Нечеткое отношение Е такое, что

I, если х = у,

О, в противном случае.

играет по отношению к операции композиции роль единицы: Е о R =

= R о Е = R. В теории четких отношений отношение Е называется отно-

шением равенства.

Для любого нечет кого отношения R определяется также обратное от-

ношение Я-1:

Ух,у е X Е~г(х,у) = R(x,y).

Свойства нечетких отношений

Различные типы нечетких отношений определяются с помощью свойств,

аналогичных свойствам обычных отношений, причем для нечетких отно-

шений можно указать различные способы обобщения этих свойств.

Е(х,у) —

22

Лекция 2 Нечеткие отношения

1. Рефлексивность'.

Е С R, УхеХ R(x, я?) = I.

2. Слабая рефлексивность'.

Ух,у € X R(x,y) С R(x,x).

3. Сильная рефлексивность:

Ух, у € X R(x,y) < I.

4. Антирефлексивность:

RrE — 0 Ух Е X R(x,х) = 0.

5. Слабая антирефлексивность:

Ух, у € X R(x,x) С R(x,y).

6. Сильная антирефлексивность:

Ух, у е X 0 < R(x, у).

7. Симметричность:

R=R~\ Ух, у 6 X R(x, у) = R(y,x).

8. Антисимметричность:

RCRC^QE, Ух,у € Х(х ф у) R(x,y) A R(y,x) = 0.

9. Асимметричность:

RC\R~i = 0, Ух, у £ X R(x,y) A R(y,x) = 0.

10. Сильная линейность:

RUR~1=U, Ух,уеХ R(x,y)y R(y,x) = I.

11. Слабая линейность:

Ух, у е X R(x, у) V R(y, х) > 0.

12. Транзитивность:

R^RoR, Ух,у,гЕХ R(x,z) R(x,y) A R(y,z).

23

Нечеткие множества и нейронные сети

Декомпозиция нечетких отношений

Одно из важнейших свойств нечетких отношений заключается в том,

что они могут быть представлены в виде совокупности обычных отноше-

ний, причем могут быть упорядочены по включению, представляя собой

иерархическую совокупность отношений. Разложение нечеткого отноше-

ния на совокупность обыкновенных отношений основано на понятии а-

уровня нечеткого отношения. Здесь для простоты будем полагать, что L

линейно упорядочено.

a-уровнем нечеткого отношения R называется обычное отношение Ra,

определяемое для всех а > 0 следующим образом:

Ra = {{х,у) е Х2|й(я:,у) о} .

Очевидно, что «-уровни нечетких отношений удовлетворяют соотно-

шению:

« ^ /3 => Ra Q R/з,

представляя собой совокупность вложенных друг в друга отношений.

Теорема. Нечеткое отношение R обладает каким-либо свойством из пе-

речисленных (кроме сильной рефлексивности, сильной антирефлексивности,

слабой линейности) тогда и только тогда, если этим свойством обладают

все его а-уровни.

Эта теорема играет важную роль в теории нечетких отношений. Во-

первых, она показывает, что основные типы обычных отношений и их

свойства могут быть обобщены и на случай нечетких отношений, и приво-

дит ясный способ такого обобщения. Во-вторых, оказывается, что основ-

ные типы нечетких отношений могут быть представлены как совокуп-

ность, иерархия обычных отношений того же типа. И если решени-

ем практической задачи является получение на множестве X некоторо-

го отношения заданного типа, например эквивалентности или порядка,

то построение на X соответствующего нечеткого отношения позволяет

получать сразу ансамбль необходимых обычных отношений, а это дает

возможность учитывать неоднозначность решений, присущих практиче-

ским ситуациям, и предоставляет лицу, принимающему решение, неко-

торую свободу выбора. В-третьих, теория нечетких множеств, допуская

подобную неоднозначность возможных решений, ограничений и целей,

дает возможность оперировать сразу всей совокупностью таких объектов

как единым целым.

Нечеткое отношение R может быть представлено в следующем виде:

R = U aRa,

а

24

Лекция 2

Нечеткие отношения

aRa(x,y') =

где отношения aRa определяются следующим образом:

а, если Ra(x, у) = 1,

О в противном случае.

Кроме всех вышеописанных свойств, выполняющихся для всех си-

уровней, могут быть определены аналогичные свойства, выполняющиеся

только для одного или нескольких ct-уровней. Приведем примеры таких

«-свойств, предполагая, что элемент а фиксированный:

а-симметричность

Чх,у G X R(x,y) а => R(y,x)^a;

а -транзитивност ь

\/x,y,zeX R(x,y) a, R(y, z) а => R(x, z) R(x, у) Л R(y, х).

Аналогично могут быть определены и другие a-свойства. Они мо-

гут рассматриваться в задачах, в которых вводит ся порог на силу отноше-

ния R либо ищется такое а, при котором Ra обладает требуемым свой-

ством.

Транзитивное замыкание нечетких отношений

Большое значение в приложениях теории нечетких отношений игра-

ют транзитивные отношения. Они обладают многими удобными свой-

ствами и определяют некоторую правильную структуру множества X.

Например, если отношение R в X характеризует сходство между объекта-

ми, то транзитивность такого отношения обеспечивает возможность раз-

биения множества X на непересекающиеся классы сходства. Если же от-

ношению в X придать смысл «предпочтения» или «доминирования», то

транзитивность такого отношения обеспечивает возможность естествен-

ного упорядочения объектов множества X, существование «наилучших»,

«недоминируемых» объектов и т. п. Поэтому представляет большой инте-

рес возможность преобразования исходного нетранзитивного отношения

в транзитивное. Такое преобразование обеспечивает операция транзитив-

ного замыкания нечеткого отношения.

Транзитивным замыканием отношения R называется отношение R,

определяемое следующим образом:

R = R1 U R2 U... U Rk U ...,

25

Нечеткие множества и нейронные сети

где отношения Rk определяются рекурсивно:

R1 = R, Rk = R1*-1 oR, fc= 2,3,4,....

Теорема. Транзитивное замыкание R любого нечеткого отношения R тран-

зитивно и является наименьшим транзитивным отношением, включаю-

щим R, т.е. R С R, и для любого транзитивного отношения Т, такого,

что RCT, следует RCT.

Как следствие из данной теоремы получаем, что R транзитивно то-

гда и только тогда, если R= R.

Если множество X содержит п элементов, то имеем

Я = Я1 U Я2 U . . U Я".

В случае, когда R рефлексивно, имеем

Я С Я1 С ... С Я"'1 = Я" = Я”+1 = ...

Весьма полезным фак тором является то, что «-уровень транзитивно-

го замыкания нечеткого отношения Я совпадает с транзитивным замыкани-

ем соответствующего «-уровня:

(Я)а = (Яа), для всех а^О.

Заметим, что при транзитивном замыкании нечеткого отношения Я

в общем случае сохраняются лишь некоторые свойства отношения Я.

Такими свойствами являются рефлексивность, симметричность, линей-

ность и транзитивность.

Проекции нечетких отношений

Важную роль в теории нечетких множеств играет понятие проекции

нечеткого отношения. Дадим определение проекции бинарного нечеткого

отношения.

Пусть muQ(x, у) — функция принадлежности нечеткого отношения

в U х V. Проекции Qu и Qv отношения Q на U и V — есть множества в U

и V с функцией принадлежности вида

UQu(^) = sup pQ(x,y),

V

PQv(x) = sup PQ(x,y).

и

26

Лекция 2 Нечеткие отношения

Условной проекцией нечеткого отношения Q на U, при произвольном

фиксированном у0 е V, называется множество Ри с функцией принад-

лежности вида уРи (ж|уо) — Hq(x, уо)-

Аналогично определяется условная проекция на V при заданном

хо € U:

РрЛу^о) =HQ(x0,y).

Из данного определения видно, что проекции Qu и Qy не влияют на

условные проекции Ри и Ру, соответственно. Дадим далее определение,

которое учитывает их взаимосвязь.

Условные проекции второго типа определяются следующим образом:

МРс, (^lz/o) = , PQv Ш > О,

pqvW)

PPu (уМ = yQ (т0) > о.

Если p.Qv (у0) = 0 или yQv (то) = 0, то полагаем, соответственно, что

УРи (Фо) = о или уРи (г/|а?о) = 0.

Заметим, что условные проекции первого типа содержатся в соот-

ветствующих проекциях второго типа.

Пусть U и V — базовые множества, Q — нечеткое отношение в U х V

и Qu и Qy — его проекции на U и V, соответственно.

Нечеткие множества Qu и Qy называются независимыми, если

Q = Qu х Qv

Следовательно, они независимы по первому типу, если

^о(^У) = l*Qu(x) ^/J.Qv(y),

и независимы по второму типу, если

PQ(x,y)=fiQv(х) • HQV(у).

В противном случае проекции Qu и Qy являются зависимыми (со-

ответствующего типа).

Независимость второго типа можно интерпретировать следующим

образом. Данные соотношения с учетом произвольности х0 и и0 перепи-

шем в виде

Л<э(я,у) = ypv(x\y')nQv(y'),

Р<э(х,у) = ypv(,y\x)nQcr(x).

27

Нечеткие множества и нейронные сети

Лекция 3. Классы нечетких отношений

В лекции приводится классификация нечетких отношений, рассмат-

риваются классы нечетких отношений сходства и различия, а также класс

нечетких порядков. В качестве примеров применения теории нечетких отно-

шений рассматриваются задачи нечеткой классификации и нечеткого упоря-

дочения.

Ключевые слова: отношение сходства, отношение различия, нестро-

гие порядки, строгие порядки, слабые порядки.

Все типы нечетких отношений в зависимости от свойств, которы-

ми они обладают, могут быть разделены на три больших класса. В первый

класс входят симметричные отношения, которые обычно характеризуют

сходство или различие между объектами множества X. Второй класс об-

разуют антисимметричные отношения; они задают на множестве X отно-

шения упорядоченности, доминирования, подчиненности и т. п. Третий

класс состоит из всех остальных отношений.

Отношения каждого класса, в свою очередь, могут быть разделены

на подклассы в зависимости от выполнения условий рефлексивности и

антирефлексивности.

Рефлексивные и симметричные отношения обычно называют отноше-

ниями сходства, толерантности, безразличия или неразличимости. В даль-

нейшем эти отношения будем называть отношениями сходства и обозна-

чать буквой S. Антирефлексивные и симметричные отношения называют-

ся отношениями различия и обозначаются буквой D. Отношения сходства

и от ношения различия двойственны друг другу.

Антисимметричные отношения, называемые предпорядками и обо-

значаемые буквой Р, в зависимости от выполнения условия рефлексив-

ности или антирефлексивности делятся на нестрогие и строгие порядки.

Из отношений третьего класса, обозначаемых буквой R, обычно вы-

деляют лишь рефлексивные отношения, которые будут называться сла-

быми порядками.

На следующем уровне классификации из каждого класса отноше-

ний могут быть выделены отношения специального вида. Определяю-

щим условием для них является условие транзитивности. Оно устанавли-

вает связь между силой отношения для различных пар объектов из X. Эта

связь может быть очень слабой, а может накладывать достаточно сильные

ограничения на возможные значения силы отношения между объектами

28

Лекция 3 Классы нечетких отношений

из X. Число отличающихся друг от друга условий транзитивности зависит

от типа отношения, для которого они формулируются.

Условия транзитивности зависят от вида операций, с помощью ко-

торых они определяются. Наиболее общими условиями транзитивно-

сти являются условия, определяемые с помощью решеточных операций

V и А в L. Более частыми являются условия, определяемые с помо-

щью дополнительных операций в L и зависящих от конкретного вида L.

В этих случаях указывается вид соответствующего множества L. Далее

мы будем рассматривать нечеткие отношения, определенные на множе-

стве L = [0,1].

Отношения сходства и различия

Симметричное и рефлексивное нечеткое отношение сходства явля-

ется аналогом обычного отношения толерантности. Нечеткие отношения

сходства обычно задаются с помощью матриц сходства, связи между объ-

ектами, либо с помощью неориентированных взвешенных графов. Мат-

рицы сходства могут быть получены как в результате измерения некото-

рого физического параметра, так и в результате опроса экспертов, ко-

торые для каждой пары объектов из X указывают их степень сходства в

некоторой шкале сравнений.

Условие транзитивности для нечетких отношений сходства обычно

формулируются в виде

S D S о S,

которое при различных определениях операции композиции приводит

к различным условиям транзитивности. Наиболее распространенными

условиями транзитивности являются следующие:

• (А)-транзитивность

Vx,y,z е X ns(x,z) y.s(x,y) Ays(y,z).

• (-)-транзитивность

Vx,y,z е X ys(x, z) ys(x,y) • ys(y,z).

• (Д)-транзитивность

Vrr, у, z G X /dS(x, z) Vs(x, y) + Ps(y, z) - 1.

Наиболее интересными свойствами обладает (А)-транзитивное от-

ношение сходства S, которое является обобщением обычного отноше-

ния эквивалентности. Это отношение называется нечетким отношением

29

Нечеткие множества и нейронные сети

эквивалентности или отношением подобия. Нетрудно показать, что лю-

бой a-уровень нечеткого отношения эквивалентности является обычным

отношением эквивалентности и, следовательно, определяет разбиение

множества объектов X на непересекающиеся классы эквивалентности.

Из вложенности «-уровней нечеткого отношения следует и вложенность

разбиений множества X, соответствующих различным «-уровням, при-

чем с уменьшением а происходит укрупнение классов эквивалентности

«-уровней. Таким образом, нечеткое отношение эквивалентности задает

иерархическую совокупность разбиений множества X на непересекаю-

щиеся классы эквивалентности.

Нечеткое отношение эквивалентности, в отличие от произвольного

отношения сходства, определяет совокупность разбиений множества X на

классы эквивалентности, благодаря тому, что условие транзитивности на-

кладывает дополнительно сильные ограничения на возможные значения

степени принадлежности. В случае, когда L = [0,1], отношение сходства

S транзитивно тогда и только тогда, если для любых x,y,z е X из трех

чисел ys(.y, z),ys(x-, z), по крайней мере, два числа равны друг

другу и по величине не превышают третье. Таким образом, нечеткое отно-

шение эквивалентности обладает многими полезными свойствами из-за

своего довольно специфического вида.

Отношением различия D называется симметричное и антирефлек-

сивное нечеткое отношение. Отношение различия двойственно отношению

сходства. В случае, когда L = [0,1], эти отношения могут быть получены

друг из друга с помощью соотношения:

= 1 - ps(x,y),

что можно записать в алгебраической форме как D = S.

Ультраметрикой называется отношение различия, удовлетворяющее

следующему неравенству:

Vx,y,z е X pD(x,z} < pD(x,y} V pD(y, z).

Очевидно, что это условие двойственно условию (Л)-транзитивности.

Понятие ультраметрики первоначально возникло и изучалось в кластер-

ном анализе при исследовании свойств меры различия между объекта-

ми, определяющих естественное представление множества обьектов в

виде дерева разбиений. Представление ультраметрики с помощью систе-

мы вложенных друг в друга отношений эквивалентности было также из-

вестно в кластерном анализе, однако лишь в рамках теории нечетких от-

ношений это представление получило естественное объяснение.

Метрикой называется отношение различия, удовлетворяющее нера-

30

Лекция 3

Классы нечетких отношений

иенству треугольника:

Vs, у, z е X z) pp(s, у) + рт>(у, z).

От метрики обычно требуют выполнения условия сильной антире-

флексивности. Метрика, удовлетворяющая лишь простому условию ан-

тирефлексивности, называется псевдометрикой. Двойственным по отно-

шению к метрике является (Д)-транзитивное отношение сходства.

Двойственным условию (-)-транзитивности является следующее усло-

вие:

\/x,y,zE X pd(x,z) < pD(x,y') + pD(y,z) - pD(x,y)pD(y,z).

Задачи нечеткой классификации

Пусть имеется набор X фотографических портретов всех членов

нескольких семей. Требуется разделить этот набор на группы так, чтобы в

каждой оказались портреты членов только одной семьи. Пусть /i(s, у) —

функция принадлежности нечеткого бинарного отношения сходства на

заданном наборе фотографий. Для каждой пары фотографий х и у значе-

ние /i (s, у) есть субъективная оценка человеком степени сходства х и у.

Это нечеткое отношение можно рассматривать как своего рода «экспери-

ментальные данные», отражающие понимание человеком понятия «сход-

ства» в данной задаче. Следующий этап — использование этих «данных»

для требующейся классификации фотографий.

Заметим, что нечеткое отношение /i(s, у) обладает естественными

свойствами рефлексивности и симметричности. Оно называется одно-

шаговым отношением, в том смысле, что описывает результаты лишь

попарного сравнения портретов друг с другом. Для /i (s, у) вводится п-

шаговое отношение fn(x, у) следующим образом:

fn(x,y)= sup min{/i(s,si),.. ,/i(s„-i,?/)}.

IE1.. .Xn— 1

Это отношение является n-арной композицией исходного «эксперимен-

тального» отношения fi (s, у) и представляет собой в некотором смысле

его уточнение. Нетрудно показать, что для любых х, у Е X выполняется

цепочка неравенств

О /1(^,2/) < /2(2:,?/) ^ ... < /n(s.y) < ... < 1.

из которой следует, в частности, что для любых х, у Е X последователь-

ность {fk(x, '</)} имеет предел при к —* оо. Таким образом, существует

31

Нечеткие множества и нейронные сети

предельное отношение сходства, определяемое равенством

/(ж, у) = lim fa(х, у), для всех х, у е X.

к—>оо

Это предельное отношение является конечным результатом обра-

ботки результатов нечетких измерений fa (х, у) и следующим образом ис-

пользуется для классификации.

Для произвольного числа А (0 < А < 1) вводится обычное (не нечет-

кое) отношение R\:

Rx(x,y) fax,y)^X.

Нетрудно показать, что для любого А (0 < А < 1) R\ есть отноше-

ние эквивалентности в X, т. е. для любых х, у е X выполняются обычные

аксиомы эквивалентности

(1) Яд (ж, ж) — рефлексивность,

(2) R\(x, у) => R\(у, х) — симметричность,

(3) Rx(x,y)&R\(y, z) => Rx(x, z) — транзитивность.

Заметим, что (3) есть следствие того, что предельное нечеткое отно-

шение fax, у) обладает свойством нечеткой транзитивности

fax, z) min{fax, у), fay, z)}, для всех х, у, z е X.

Окончательный этап алгоритма классификации — разбиение мно-

жества X на классы эквивалентности по полученному отношению Яд.

Выбор величины порога А в этом алгоритме осуществляется, исхо-

дя из условий начальной задачи. В приведенном выше примере с фото-

графиями этот выбор осуществляли следующим образом. Пусть имеется

набор из 20 фотографий представителей 3 семей. Тогда величину А выби-

рают так, чтобы в результате реализации алгоритма классификации полу-

чилось 3 класса эквивалентности по отношению Яд.

Порядки и слабые порядки

Антисимметричное, транзитивное нечеткое отношение Р называет-

ся отношением упорядочения или порядком. Мы будем рассматривать толь-

ко строгие порядки, т. е. порядки, для которых выполняется свойство ан-

тирефлексивности. Свойства нестрогих (рефлексивных) порядков во мно-

гом совпадают со свойствами строгих порядков.

Различные порядки отличаются друг от друга требованиями, предъ-

являемыми к условию транзитивности. Слабейшее из этих требований —

условие ацикличности отношения строгого порядка Р, наиболее жесткие

32

Лекция 3

Классы нечетких отношений

требования — условия линейной транзитивности и условие квазисерий-

ности.

Если для отношения сходства условие транзитивности обычно за-

писывают в виде S D S о S и различные способы определения опера-

ции композиции позволяют задавать разные типы транзитивности, при-

чем оказывается, что таких типов существует не так уж и много, то для

отношения порядка условие транзитивности нечеткого отношения удобно

записывать в виде, аналогичном условию транзитивности обычных по-

рядков:

Р(х, у) > 0, Р(у, z) > 0 P(x,z) Р(х,у) * P(y,z),

где * — некоторая операция в L. Оказывается, что из множества всех от-

ношений порядка можно выделить значительное количество отличаю-

щихся друг от друга классов порядков специального вида, определяемых

как способом задания операции * в L, так и способом записи условия

транзитивности. Далее перечислим некоторые условия транзитивности,

определяющие эти классы нечетких строгих порядков. Учитывая асиммет-

ричность отношения строгого порядка Р, будем полагать у) 0, ес-

ли Р(у, х) = 0.

• Ацикличность'.

Ух0,Х1,. .. ,хп,

Р(х0,х1)>0, Р(Х!,Х2) >0,...,Р(хп-1,Хп) >0 => Р(хо,хп)^О-

• Слабая транзитивность:

Vx,y,z Р(х,у) > 0, P(y,z) > 0 => Р(х, z) > 0.

• Отрицательная транзитивность:

\/x,y,z P(x,y)^0, P(y,z)^0 => Р(х, z)^0.

• (-)-транзитивность:

\fx,y,z Р(х,у) > 0, Р(у, z) > 0 => Р(х, z) Р(х,у) Р(у, z).

• (Л)-транзитивность:

Vx,y,z Р(х,у) > G, P(y,z) > 0 => Р(х, z) Р(х, у) Л P(y,z).

• (1/2, +)-транзитивность:

Vx, у, Z Р(х, у) > 0, Р(у, z) > 0 => Р(х, z) p(^y)+P(y^z)

33

Нечеткие множества и нейронные сети

• Сильная транзитивность'.

\/x,y,z Р(ж, у)>0, Р(у, z) О => Р(х, z) Р(х, у) VP(y, z).

• Сверхсильная транзитивность'.

\/x,y,z Р(х,у) > 0. P(y,z)>0 => Р(х, z) > Р(х, у) V Р(У, z).

• Метрическая транзитивность'.

\/x,y,z Р(х,у) 0, P(y,z) 0 =>

=> Р(х, у) + Р(у, z) Р(х, z) Р(х, у) V Р(у, z).

• Квазисерийность'.

Vx,y,z P(x,y)^0, P(y,z)~^0 => Р(х, z) = Р(х, у) V Р(у, z).

• Ультраметрическая транзитивность'.

\/x,y,z Р(х,у) > 0, P(y,z) > 0 =>

=> Р(х, у) V Р(у, z) Р(х, z) Р(х, у) Л Р(у, z).

В общем случае предполагается, что рассмотренные условия транзи-

тивности определены для L = [0,1], хотя некоторые условия могут быть

обобщены и на случай, когда L является решеткой.

Условия ацикличности, слабой транзитивности и отрицательной

транзитивности нечеткого отношения Р равносильны соответственно

условиям ацикличности, транзитивности и отрицательной транзитивно-

сти обычного отношения Ро, определяемого следующим образом:

1, если Р(х, у) > 0,

0 в противном случае.

Аналогичные свойства могут быть определены как a-свойства для

различных «-уровней Ра отношения Р.

В отличие от первых трех свойств, остальные свойства более спе-

цифичны для нечетких отношений и в большей мере учитывают согла-

сованность силы отношения между элементами множества X. этих

свойств также могут быть сформулированы «-свойства.

Частным случаем сильного порядка (порядка, удовлетворяющего усло-

вию сильной транзитивности) является метрический порядок. Для асим-

метричных отношений условие метрической транзитивности эквивалент-

но неравенству треугольника.

Ро(х,у) =

34

Лекция 3

Классы нечетких отношений

Условие квазисерийности определяет нечеткую квазисерию. Каж-

дый a-уровень нечеткой квазисерии является обыкновенной квазисери-

сй, т. е. удовлетворяет условиям

Pa(x,y),Pa(y,z) => Pa(x,z);

Pa(x,y),-,Pa(z,y) => Pa(x,z);

->Pa(y,x),Pa(y,z) =Ф Pa(x,z).

Поскольку обычная квазисерия определяет разбиение множества X

на упорядоченные классы эквивалентности, нечеткая квазисерия опре-

деляет разбиение множества X на упорядоченные классы эквивалентно-

сти на каждом «-уровне. Эти разбиения вложены друг в друга; таким об-

разом, нечеткая квазисерия определяет иерархию разбиений множества

X на упорядоченные классы эквивалентности.

Частным случаем метрических порядков, помимо квазисерии, явля-

ется линейный порядок, определяемый условием линейной транзитивно-

сти. Линейный порядок при интерпретации Р(х, у) как силы предпочте-

ния альтернативы х над альтернативой у задает на множестве альтерна-

тив X некоторую аддитивную функцию полезности, которая может быть

определена наХ, например, с помощью соотношения/(а?) = sup Р(х, у).

уЕХ

Ультраметрическая транзитивность построена по аналогии с метри-

ческой транзитивностью, однако для антисимметричных отношений она

не эквивалентна ультраметрическому неравенству P(x,z) Р(х,у) V

р(у,х)-

Между строгими порядками (асимметричными отношениями) и сла-

быми порядками (рефлексивными отношениями) существует тесная связь.

Эти порядки могут быть получены друг из друга с помощью ряда преоб-

разований.

Если на L задана операция дополнения, т. е. такая унарная опера-

ция -1, что на L выполняются тождества

—(—!«) = «, -(« Л (3) = -та V ->/?, -(« V (3) = Л

то на множестве нечетких отношений может быть задана операция до-

полнения следующим образом:

Рц(х,у) = ТйСг,?/),

и на множестве нечетких отношений будут выполняться тождества

7? = R, BAJT = R ПТ, ЙПТ = R U Т.

Если на множестве нечетких отношений задана операция дополне-

ния, то из отношения строгого порядка Р могут быть получены:

35

Нечеткие множества и нейронные сети

• Отношение сходства S = Р U Р~

• Отношение различия D = Р U Р-1;

• Отношение слабого порядка R = Р-1.

Транзитивностью отношения Р определяется тот или иной уровень

транзитивности отношений S и R. В частности, если Р является нечет-

кой квазисерией, то определяемое им отношение S является нечетким

отношением эквивалентности, а отношение R будет нечетким квазипо-

рядком.

Нечеткие отношения порядка могут быть получены многими спосо-

бами и допускают различную интерпретацию. Они могут выражать либо

значение какого-либо физического параметра, характеризующего интен-

сивность доминирования х над у, либо усредненную по множеству крите-

риев или индивидуумов силу предпочтения между объектами. Они могут

быть получены с помощью шкалы сравнений, которой эксперты измеря-

ют интенсивность предпочтений при попарных сравнениях альтернатив,

могут выражать уверенность, возможность, вероятность доминирования

и т.п.

Задачи нечеткого упорядочения

Любую задачу принятия решений можно сформулировать как задачу

отыскания максимального элемента в множестве альтернатив с заданным

в нем отношением предпочтения. Однако во многих реальных ситуациях

в множестве альтернатив можно определить лишь нечеткое отношение

предпочтения, т. е. указать для каждой пары альтернатив х и у лишь сте-

пени, с которыми выполняются предпочтениях У у ну у х. В таких

случаях задача принятия решения становится неопределенной, посколь-

ку неясно, что такое максимальный элемент для нечеткого отношения

предпочтения. Для двух типов нечетких отношений можно предложить

способы упорядочения элементов конечного множества, в котором зада-

но нечеткое отношение. Способы эти сводятся к тому, что для каждого из

рассматриваемых типов нечетких отношений строится некоторая функ-

ция (напоминающая функцию полезности), и элементы множества упо-

рядочиваются по соответствующим им значениям этой функции.

Пусть f(x,y) — функция принадлежности бинарного нечеткого от-

ношения в множестве X (например, отношения нестрого предпочтения).

Допустим, что рассматривается задача упорядочения элементов конечно-

го множества Т = {.t'i, ... ,хп). Упорядочение можно осуществлять по

36

Лекция 3

Классы нечетких отношений

значениям следующей функции:

/(a;i|T) = min f(xi\xj),

3

где Xj еТ,а функция

f(x.\x.) =_______f^xi)_________

3 max{f(xi,xj),f(xj,xi)}

Для вычисления значений функции f(Xi |Т) удобно пользоваться следую-

щим равенством:

,/ • Г/(^,Ж1) f(Xi,Xn)\

[/(жцЖг) f(xn,Xi) J

По отношению к этому упорядочению максимальным в множестве Т яв-

ляется элемент х® такой, что

f(xi |Л = max f(xk\T).

Рассмотрим еще одну задачу упорядочения, иллюстрируемую следу-

ющим примером.

Требуется решить, кто из детей: старший сын xlt младший сын а?2

или дочь хз больше всего похож на отца z. Заданы «результаты измере-

ний»: xi и Х2 взятые отдельно, похожи на отца со степенями 0,8 и 0,5

соответственно; х-2 и хз, взятые отдельно, похожи на отца со степенями

0,4 и 0,7; наконец, Xi и х3, взятые отдельно, похожи на отца со степенями

0,5и0,3.

Таким образом, в этой задаче, в отличие от предыдущей, имеет-

ся стандартный элемент (шаблон) для упорядочиваемого множества Т,

т. е. элемент, обладающий свойствами, общими для всех элементов этого

множества. Иначе говоря, если f(x, у) — нечеткое отношение в X D Т

(например, отношение сходства), то

/(z, Xi) = 1, ДЛЯ любого Xi е Т.

При наличии стандартного элемента для каждой пары элементов х

и у множества Т задаются величины f(x, у : z), f(y, х : z), т. е. степени от-

ношения (например, сходства) х и у, взятых отдельно, к z. Упорядочение

элементов множества Т с заданным таким способом нечетким отноше-

нием предлагается осуществлять в соответствии со значениями функции

, . ff(xj,xi : z) f(xj, xn:z)]

. (,zj . z) . zy-’ f(Xn,Xj : z) J ’

37

Нечеткие множества и нейронные сети

Максимальным в смысле этого упорядочения является элемент х®

такой,что

: z) = max f(xk\T ; z).

Xk^T

Для задачи о сходстве отца и детей значения этой функции таковы:

f(x1\T:z) = l, f(x2[T : z) = 4/7, /Ы7 : z) = 3/5.

Отсюда вытекает, что наиболее похож на отца старший сын, затем

следуют дочь и младший сын.

38

Лекция 4 Показатель размытости нечетких множеств. Нечеткие меры и интегралы

Лекция 4. Показатель размытости нечетких

множеств. Нечеткие меры и интегралы

В лекции вводится понятие показателя размытости нечеткого множе-

ства, рассматриваются аксиоматические и метрические способы задания по-

казателя размытости. Изучаются понятия нечеткой меры и нечеткого инте-

грала. Описываются основные классы нечетких мер. В конце лекции приво-

дятся два примера применения теории нечетких мер для решения практиче-

ских задач.

Ключевые слова: показатель размытости, нечеткая мера, нечеткий

интеграл.

Как уже говорилось в прошлых лекциях, нечеткие множества ис-

пользуются для описания плохо определенных, неоднозначно понимае-

мых ситуаций, объектов, понятий. Де Лука предложил ввести в рассмот-

рение показатель этой неопределенности, который можно было бы ис-

пользовать для оценки, классификации объектов, описываемых нечет-

кими множествами. Он же сформулировал основные свойства, которым

должен удовлетворять такой показатель, называемый показателем размы-

тости (или мерой энтропии) нечетких множеств, и в качестве этого по-

казателя был предложен функционал, аналогичный шенноновской эн-

тропии в теории информации. В настоящее время рассматриваются раз-

личные альтернативные подходы к определению показателя размытости

нечеткого множества, обсуждаются его свойства и возможные приложе-

ния.

Можно выделить несколько аспектов, связанных с понятием пока-

зателя размытости нечеткого множества. Прежде всего, это — интерпре-

тация показателя размытости как показателя внутренней неопределенно-

сти, двусмысленности, противоречивости, обусловленных неполной, ча-

стичной принадлежностью объектов множеству. Второй аспект связан с

интерпретацией показателя размытости как меры отличия нечеткого мно-

жества от обычного множества. И наконец, само существование нетриви-

ального показателя размытости, удовлетворяюшего определенным свой-

ствам, напрямую зависит от свойств алгебры нечетких множеств и харак-

теризует ее как алгебраическую структуру. В соответствии с этими тремя

аспектами и будут рассмотрены основные результаты, связанные с поня-

тием показателя размытости.

39

Нечеткие множества и нейронные сети

Аксиоматический подход к определению

показателя размытости нечеткого множества

Показатель размытости нечеткого множества можно определить как

меру внутренней неопределенности, двусмысленности объектов множе-

ства X по отношению к некоторому свойству А, характеризующему эти

объекты и определяющему в X нечеткое множество объектов А. Если

некоторый объект х е X обладает свойством А, но лишь в частичной

мере: 0 < р,д(х) < 1, то внутренняя неопределенность, двусмысленность

объекта х по отношению к свойству А проявляется в том, что он, хотя и

в разной степени, принадлежит сразу двум противоположным классам:

классу объектов, «обладающих свойством А», и классу объектов, «не об-

ладающих свойством А». Эта двусмысленность объекта х по отношению

к свойству А максимальна, когда степени принадлежности объекта х к

обоим классам равны, т. е. Дд(х) = Рл(.х) = 0,5. И наоборот, двусмыс-

ленность объекта минимальна, когда объект принадлежит только к одно-

му из этих классов, т. е. либо дд(ж) = 1, дл(ж) = 0, либо дд(ж) = О,

Мл(а:) = 1- Таким образом, глобальный показатель размытости нечеткого

множества А можно определить в виде функционала d, удовлетворяюще-

го следующим условиям:

Pl. d(A) < d(B), если А является заострением В, т. е. р,д(ж) /а в (ж)

при Дв(^) < 0,5, Дд(ж) Дв(ж) при дв(ж) > 0,5и дд(ж) — любое

при дв(ж) = 0,5;

Р2. d(A) = d(A);

РЗ. Если А П В = 0, то d(A U В) = d(A) + d(B).

Итак, показатель размытости можно рассматривать как аддитив-

ный, симметричный и строго возрастающий с увеличением размытости

нечеткого множества функционал, определенный на множестве S(X) всех

нечетких подмножеств множества X.

Можно доказать, что вещественный, определенный на А(Х) функ-

ционал является показателем размытости тогда и только тогда, если он до-

пускает представление

N

= ^тз^а{х5)),

3=1

где Tj(y) — вещественнозначные функции от у е [0,1] такие, что Т7 (0) =

= 0, Tj{y) = Tj(l — у), Tj(y) — строго возрастает на интервале [0,0,5] и

N — число элементов множества X = {.Г],..., .гЛ?}.

40

Лекция 4 Показатель размытости нечетких множеств. Нечеткие меры и интегралы

Примером коэффициента размытости может служить логарифмиче-

ская энтропия нечетких множеств:

N

j=i

где S — функция Шеннона

S{y) = ~У In?/ - (1 - у) 1п(1 - у).

Выбор конкретного показателя зависит от условий задачи. Далее мы

покажем, что показатель размытости нечетких множеств может быть за-

дан с помощью метрики. Необходимо обратить внимание на связь между

показателем размытости нечетких множеств и неопределенностью, возни-

кающей при принятии решения, к какому из двух классов, «А» или «не А»

, отнести объекты множества X. На практике человеку часто приходится

принимать подобные решения, когда необходимо отнести объект к одно-

му из двух классов, характеризующихся противоположными свойствами

типа: «белый—черный», «пригоден—не пригоден», «нравится—не нравит-

ся», «хороший—плохой» и т. п. Такая альтернатива вызывает у лица, при-

нимающего решения, неопределенность, обусловленную тем, что объек-

ты часто обладают сразу обоими противоположными свойствами, хотя и

в разной мере. Можно предположить, что показатель этой неопределен-

ности зависит от размытости ситуации, в которой принимается решение.

Допускается, что показатель неопределенности решений может удовле-

творять тем же свойствам, что и показатель размытости нечетких мно-

жеств.

Метрический подход к определению показателя

размытости нечетких множеств

Показатель размытости нечетких множеств можно определить с

помощью метрики как меру отличия нечеткого множества от ближайше-

го к нему обычного множества. Другой способ задания показателя размы-

тости с помощью метрики — это определение его с помощью расстояния

до максимального размытого множества Aq^ -. Ух е X /м0 5(ж) = 0,5

и расстояния между нечетким множеством и его дополнением. Оказыва-

ется, эти подходы имеют много общего между собой, и определяемый с

помощью метрики показатель размытости обладает многими свойствами,

сформулированными выше.

41

Нечеткие множества и нейронные сети

Множеством, ближайшим к нечеткому множеству А, называется

неразмытое множество А такое, что

Да(я) =

1, если/м (ж) > 0,5

О, если дд(ж) 0,5.

Показателем размытости называется функционал

2 N

cf(A) = — 52 iMAfe) - Ма(^)|,

j=i

который может быть представлен также в виде

2 у Ч

J=1

Если вместо расстояния Хэмминга использовать евклидово расстояние,

то получим

2

<ЦА) = ~ЙГг

N

52 (VA&j) -

3=1

Показатель размытости можно задать с помощью расстояния между

нечетким множеством и его дополнением:

d(A) = к [р(0, U) - р(А, А)] .

В случае метрики Хэмминга р(А, А) имеет вид

N N

р(А,А) = 52 |Да(ж5) - PA^j)\ = 52 12Ма(ж3) - 1|-

3=1 3 = 1

Такой показатель размытости удовлетворяет свойствам Р1 и Р2.

Далее выясним, что между показателями размытости, удовлетворя-

ющими условиям Pl, Р2, РЗ, и метриками определенного класса может

быть установлено взаимно однозначное соответствие.

Связь показателя размытости с алгебраическими

свойствами решетки нечетких множеств

Существование показателя размытости нечетких множеств оказы-

вается тесно связанным со свойствами алгебры нечетких множеств За-

де. Для алгебры обычных множеств показатель размытости со свойствами

42

Лекция 4 Показатель размытости нечетких множеств. Нечеткие меры и интегралы

Pl, Р2, РЗ вырождается в тривиальный показатель, всюду равный нулю.

Для более общих алгебр такого показателя просто не существует. Ука-