Автор: Васильев В.И.

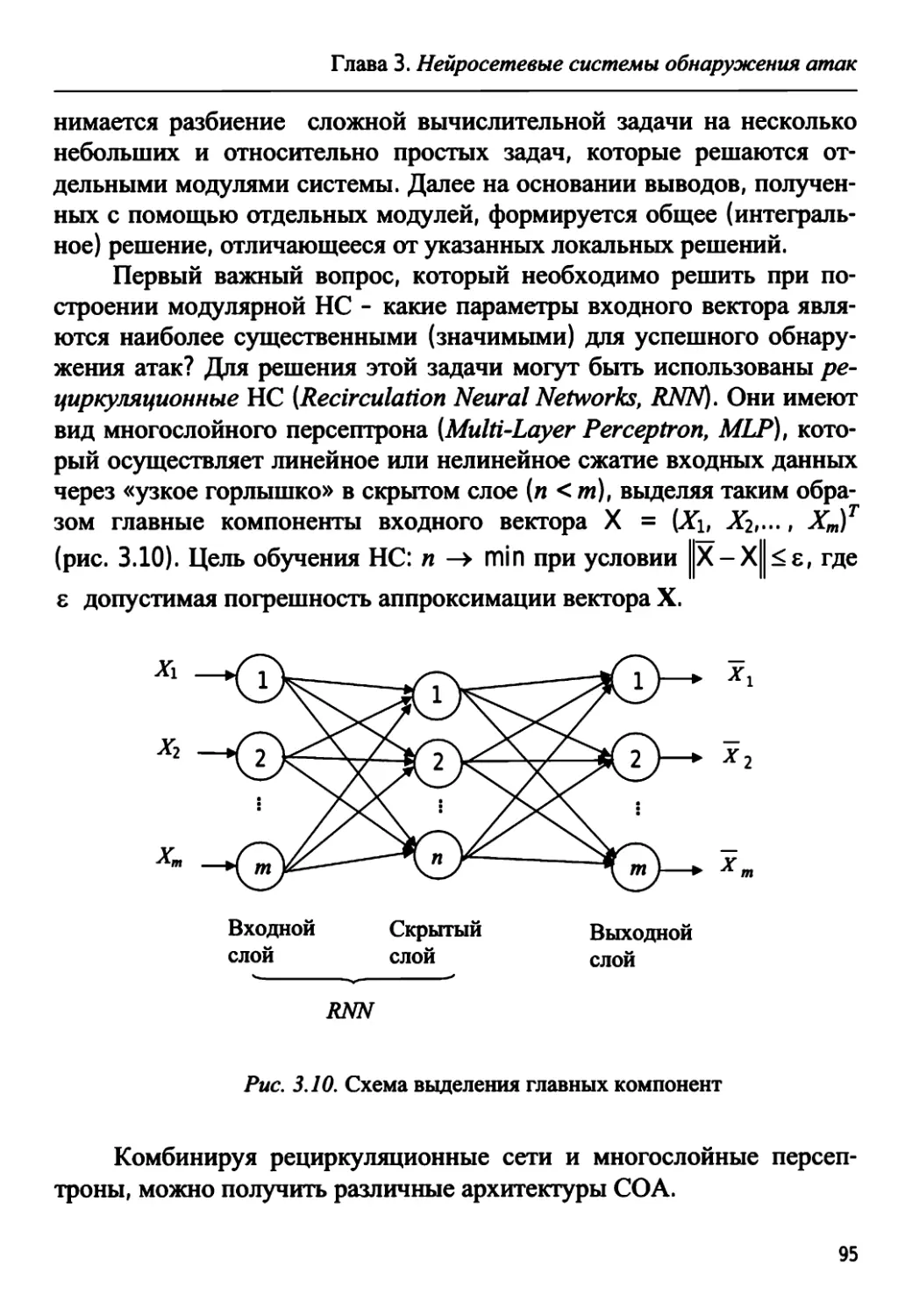

Теги: автоматика системы автоматического управления и регулирования интеллектуальная техника технология управления оборудование систем управления техническая кибернетика информационные технологии вычислительная техника обработка данных кибернетика микропроцессоры машиностроение интеллектуальные системы

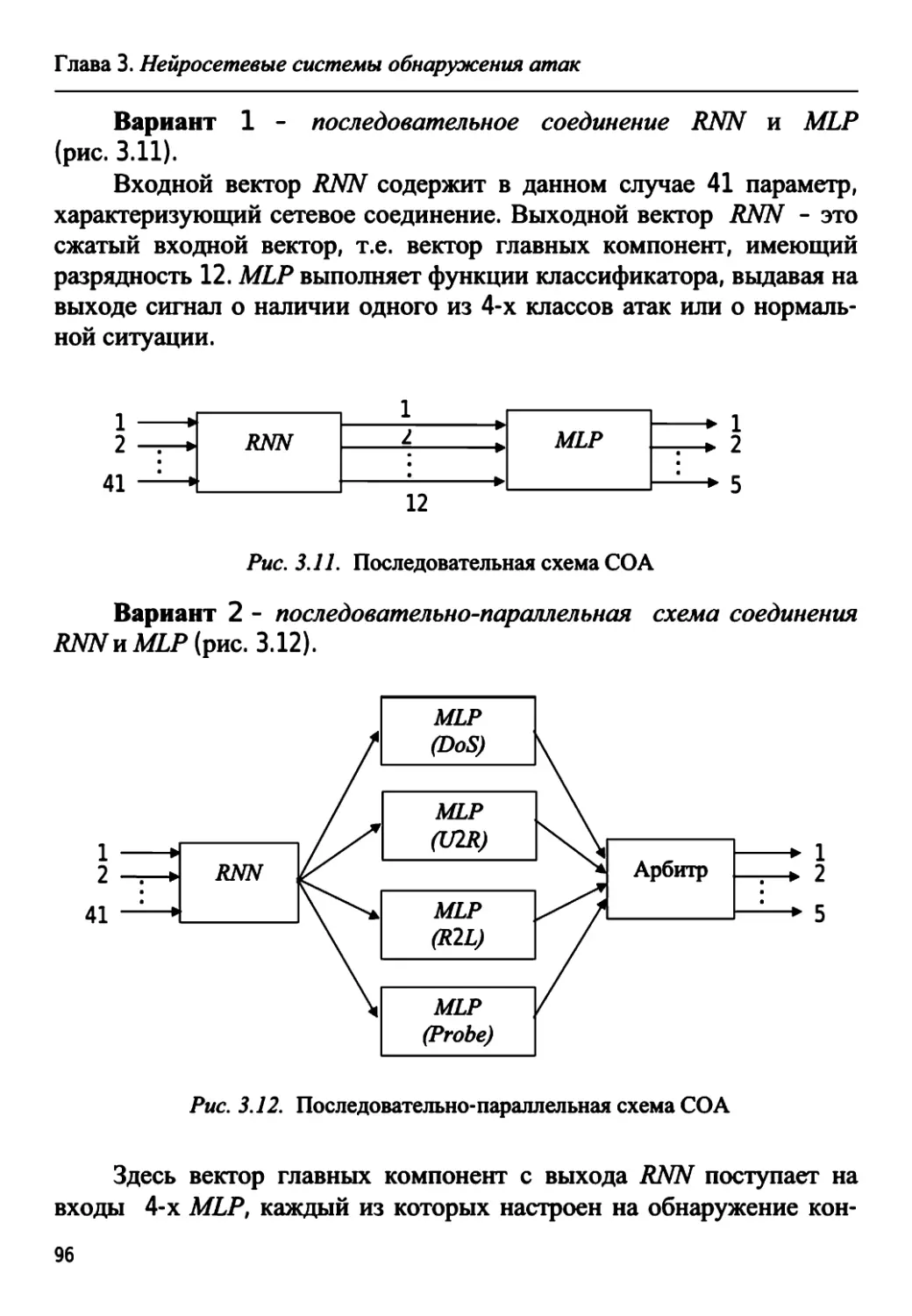

ISBN: 978-5-94275-667-3

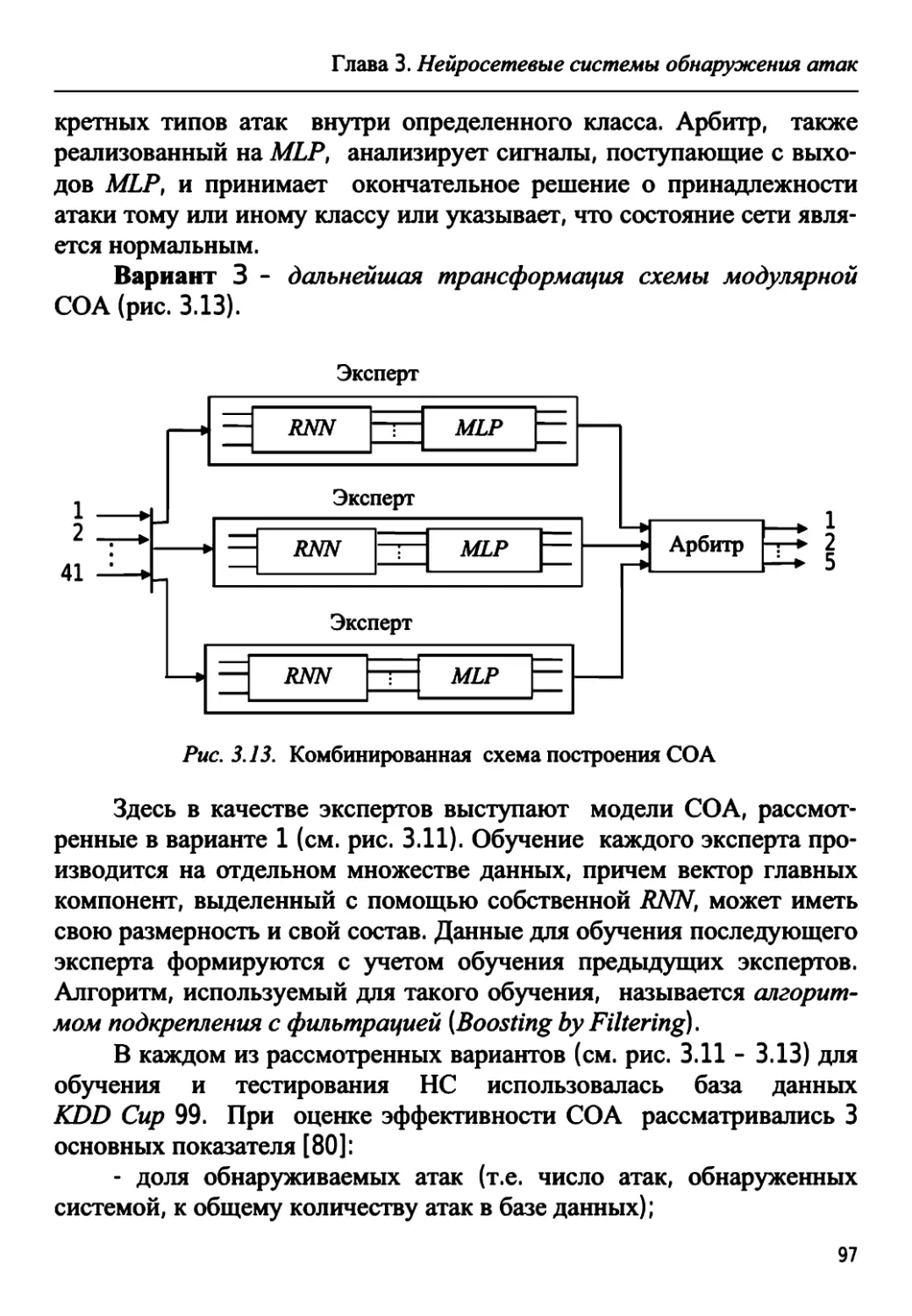

Год: 2013

D

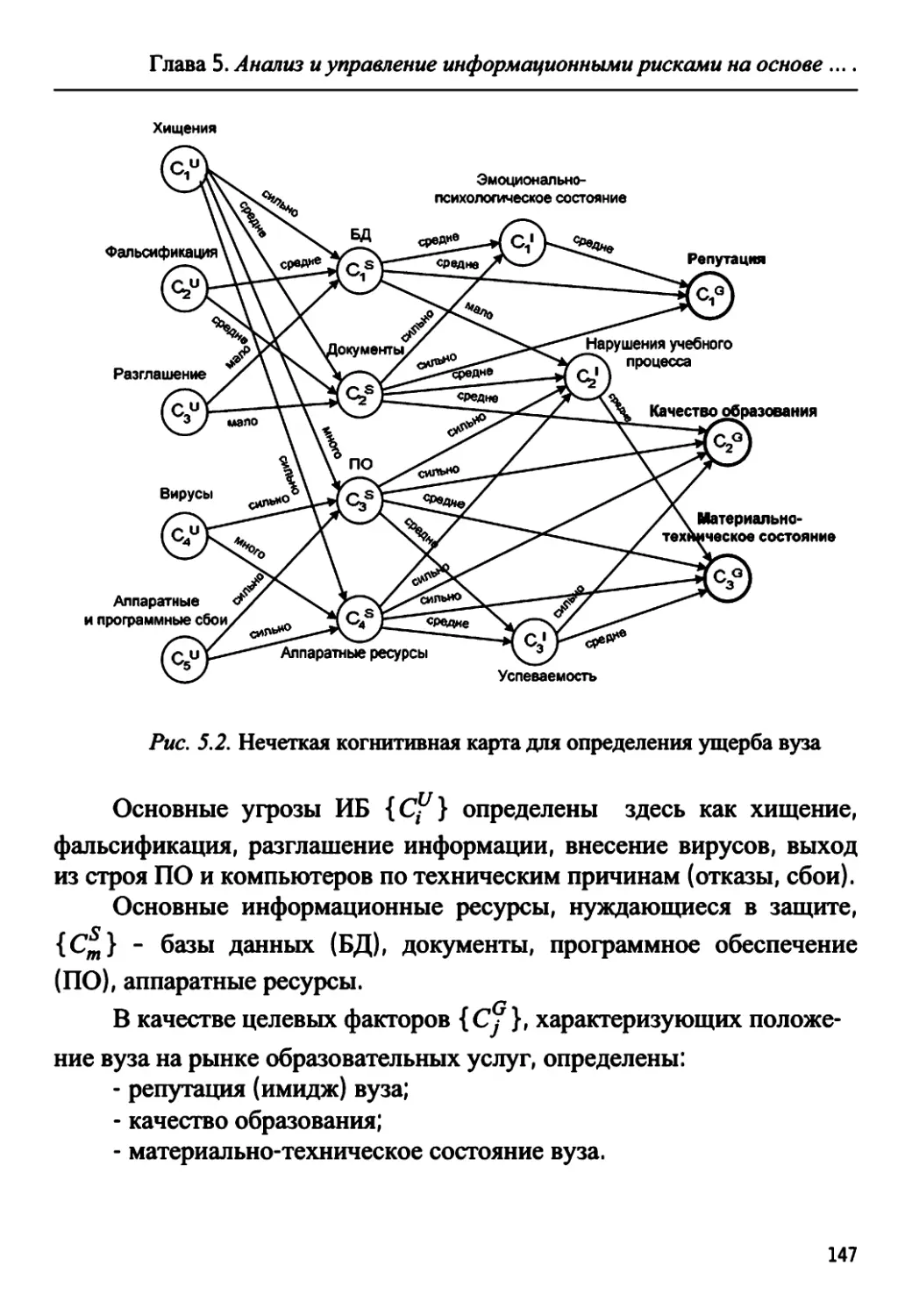

D

ДЛЯ ВУЗОВ

В.И. Васильев

ИНТЕЛЛЕКТУАЛЬНЫЕ

СИСТЕМЫ

ЗАЩИТЫ ИНФОРМАЦИИ

Издание второе, исправленное

Допущено Учебно-методическим объединением

по образованию в области информационной

безопасности в качестве учебного пособия для

студентов высших учебных заведений,

обучающихся по специализациям специальности

«Комплексное обеспечение информационной

безопасности автоматизированных систем»

МОСКВА

«МАШИНОСТРОЕНИЕ»

2013

ОГЛАВЛЕНИЕ

ВВЕДЕНИЕ 5

ГЛАВА 1. ОСНОВЫ ПОСТРОЕНИЯ ИНТЕЛЛЕКТУАЛЬ-

НЫХ СИСТЕМ ЗАЩИТЫ ИНФОРМАЦИИ 9

1.1. Системные принципы защиты информации 9

1.2. Интегрированные системы защиты информации 12

1.3. Интеллектуализация систем защиты информации 20

Контрольные вопросы 33

ГЛАВА 2. БИОМЕТРИЧЕСКИЕ СИСТЕМЫ

ИДЕНТИФИКАЦИИ ЛИЧНОСТИ 34

2.1. Биометрические технологии: классификация,

сравнительные характеристики 34

2.2. Постановка задачи распознавания образов.

Построение решающего правила 45

2.3. Нейросетевые алгоритмы биометрической

идентификации 52

2.4. Нейросетевая реализация биометрических систем

идентификации с криптозащитой 61

2.5. Биометрические системы идентификации на основе

нечетких экстракторов 67

Контрольные вопросы 73

ГЛАВА 3. НЕЙРОСЕТЕВЫЕ СИСТЕМЫ ОБНАРУЖЕНИЯ

АТАК 74

3.1. Актуальность проблемы, пути ее решения 74

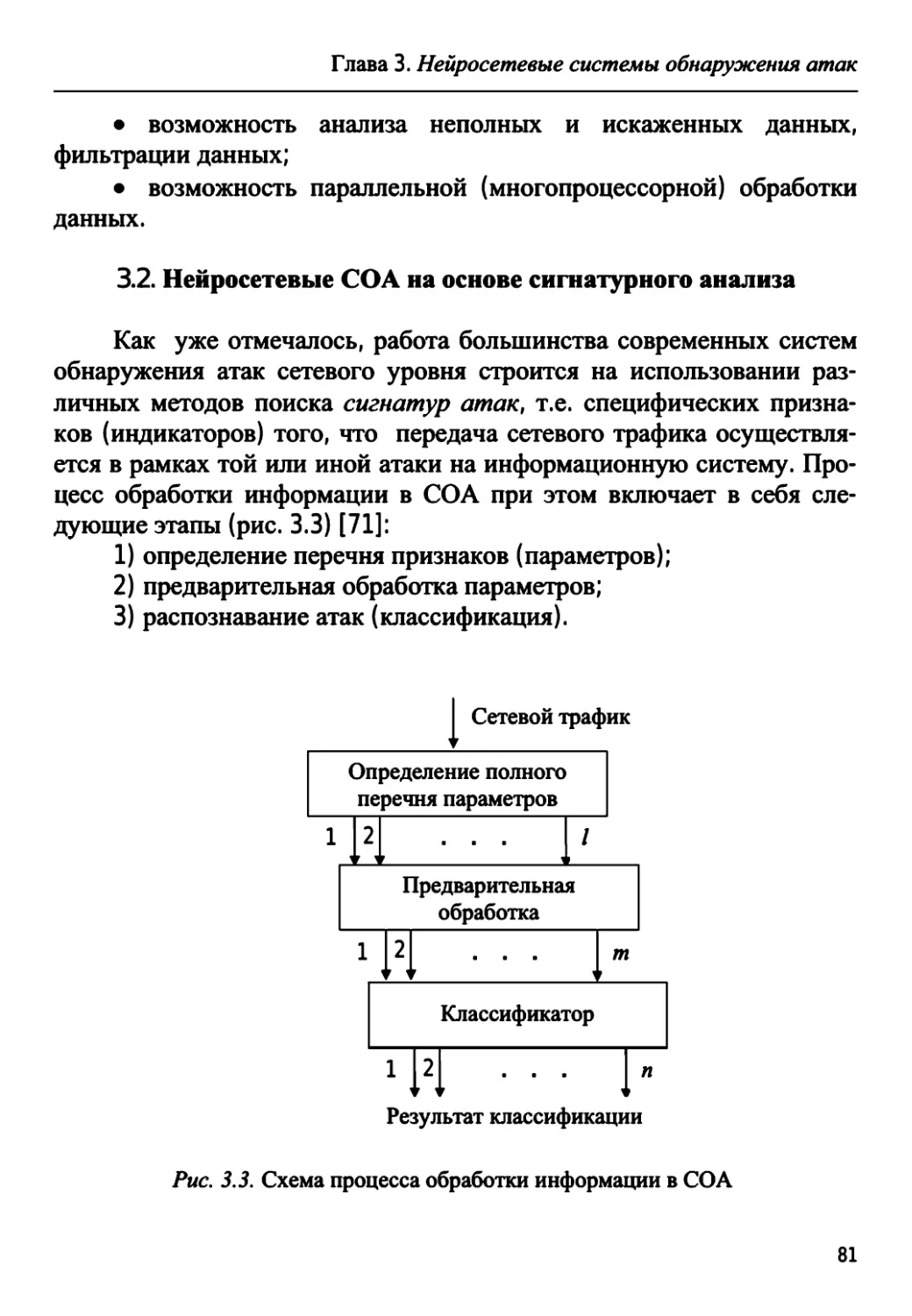

3.2. Нейросетевые СОА на основе сигнатурного анализа ... 81

3.2.1. Обнаружение атаки SYN Flood 82

3.2.2. Построение нейронечеткого классификатора 89

3.2.3. Обнаружение сетевых атак с помощью

модулярной НС 94

3.3. Обнаружение аномалий с помощью НС.

Интегрированные системы обнаружения атак 99

Контрольные вопросы 111

Оглавление

ГЛАВА 4. ИНТЕЛЛЕКТУАЛЬНЫЕ СИСТЕМЫ ЗАЩИТЫ

ИНФОРМАЦИИ НА ОСНОВЕ МЕХАНИЗМОВ

ИСКУССТВЕННЫХ ИММУННЫХ СИСТЕМ 112

4.1. Роль и место искусственных иммунных систем

в задачах защиты информации 112

4.2. Естественная иммунная система: механизмы

функционирования 115

4.3. Обнаружение аномалий процесса на основе

механизмов иммунной системы 119

4.4. Практические примеры реализации систем

обнаружения аномалий на основе технологий искусственных

иммунных систем 126

4.5. Системы антивирусной защиты на основе

искусственных иммунных систем 133

Контрольные вопросы 137

ГЛАВА 5. АНАЛИЗ И УПРАВЛЕНИЕ ИНФОРМАЦИОН-

НЫМИ РИСКАМИ НА ОСНОВЕ НЕЧЕТКИХ

КОГНИТИВНЫХ МОДЕЛЕЙ 138

5.1. Состояние вопроса 138

5.2. Методика когнитивного моделирования сложных

систем 141

5.3. Анализ информационных рисков с помощью

нечетких когнитивных карт 145

5.4. Инструментальное средство анализа и управления

информационными рисками 152

Контрольные вопросы 157

ЗАКЛЮЧЕНИЕ 158

СПИСОК СОКРАЩЕНИЙ 160

СПИСОК ЛИТЕРАТУРЫ 161

4

Введение

Миссия обеспечения

информационной безопасности

трудна, во многих случаях

невыполнима, но всегда

благородна

В. А. Галатенко

Я пришел к выводу, что наилучшими

экспертами в области безопасности

являются люди, исследующие

несовершенства защитных мер

Б. Шнайер «Секреты и ложь»

ВВЕДЕНИЕ

Современный мир - мир информационных технологий. Инфор-

мация сегодня является самым ценным и востребованным товаром.

Жизнь практически любой организации (предприятия, государствен-

ного учреждения, учебного заведения, банка и т.д.) в значительной

степени зависит от того, насколько эффективно и устойчиво функ-

ционирует ее информационная система, насколько надежно защище-

ны ее информационные ресурсы по отношению к действию возмож-

ных внешних и внутренних угроз.

Спектр угроз информационной безопасности сегодня значитель-

но расширился - это не только возможность получения несанкциони-

рованного доступа к секретной или конфиденциальной информации,

хакерские атаки или вирусы, но и тщательно спланированные компь-

ютерные преступления с целью материальной наживы или нанесения

материального и морального ущерба частным лицам и организациям,

кибертерроризм, подготовка к широкомасштабным информационным

войнам. Все больший удельный вес (по различным оценкам, до 60 -

70 %) приобретают внутренние угрозы, связанные с действиями так

называемых «инсайдеров» - штатных сотрудников организации,

умышленно или ошибочно превышающих свои полномочия при ра-

боте с информацией, следствием чего является ее утечка, несанкцио-

нированная модификация или уничтожение. Повсеместное использо-

вание Интернета в качестве глобальной сети, объединяющей сотни

5

Введение

миллионов компьютеров и пользователей по всему миру, лишь усу-

губляет ситуацию, поскольку получить доступ к ресурсам любого

(даже защищенного) компьютера, подключенного к Интернету, тео-

ретически можно с любого другого компьютера, расположенного в

сети.

Сложность решения проблемы информационной безопасности

состоит и в том, что лица, принимающие решения (руководители

высшего звена, специалисты по защите информации, системные ад-

министраторы, рядовые пользователи), вынуждены действовать в ус-

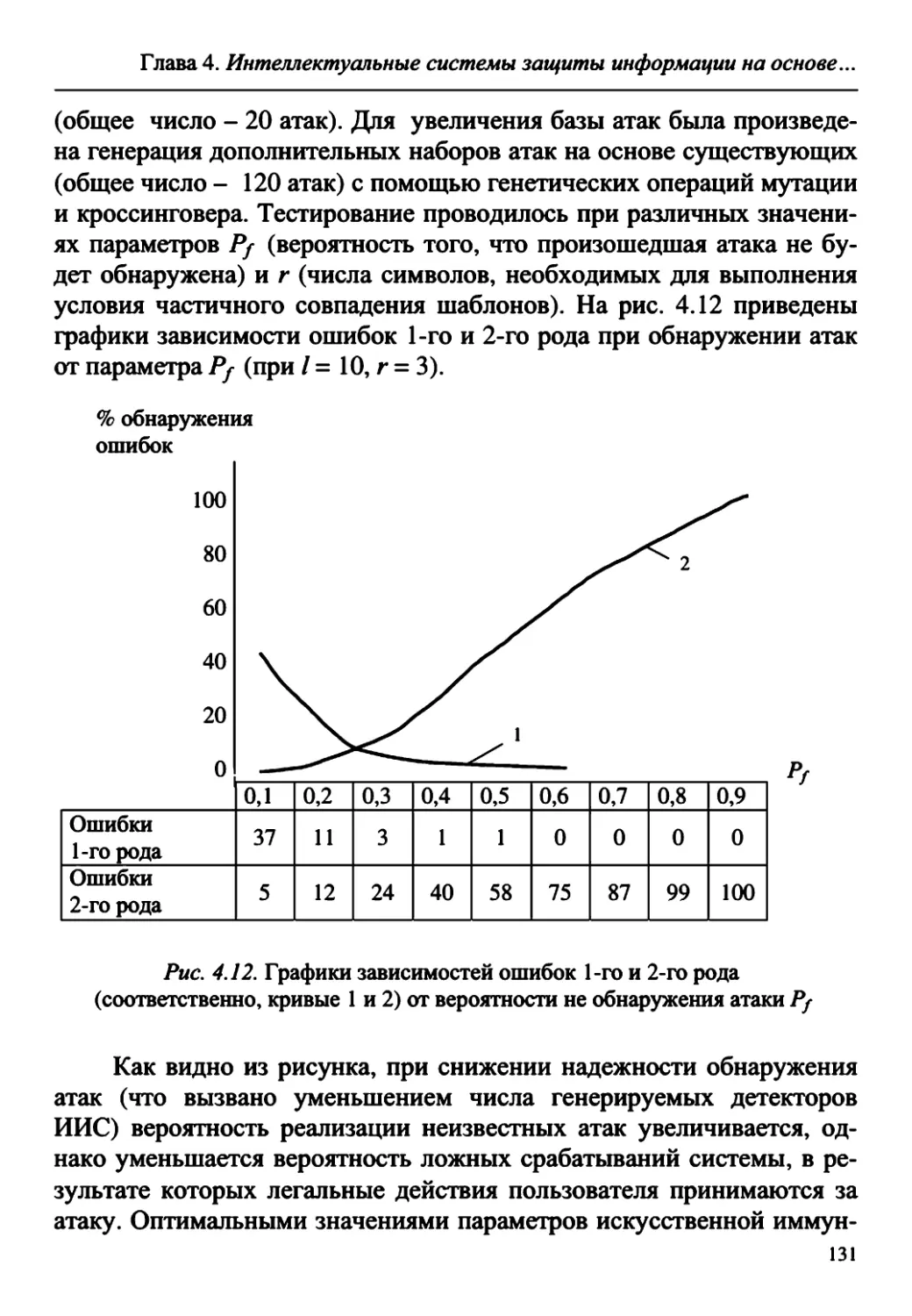

ловиях наличия факторов неопределенности, связанных с неточно-

стью и недостоверностью исходных данных, неполнотой знаний о

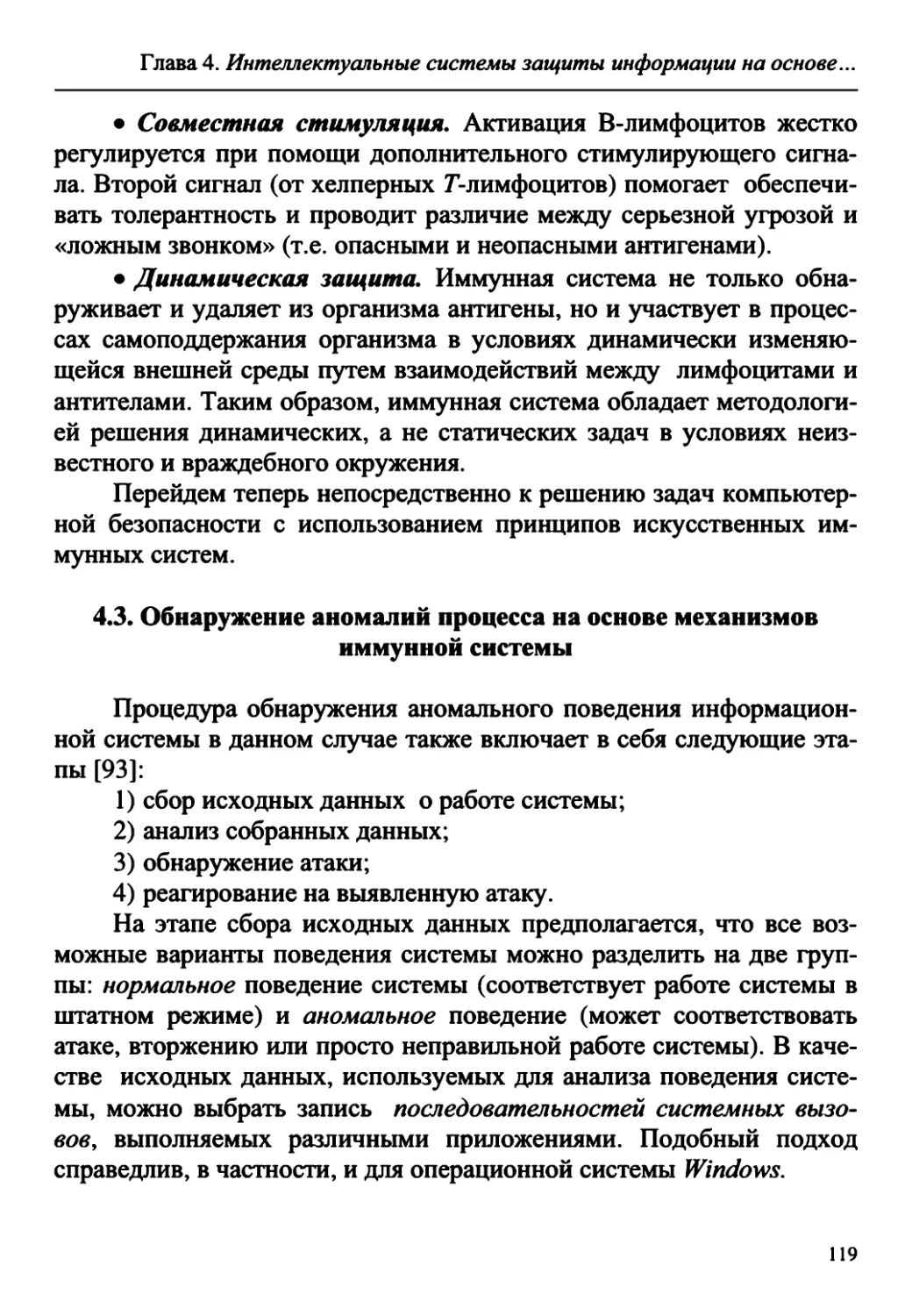

рассматриваемом объекте, неоднозначностью принимаемых решений

(известный специалист в области искусственного интеллекта

А. С. Нариньяни назвал эти факторы НЕ-факторами [1]). Попытки ав-

томатизации отдельных функций защиты информации с помощью

соответствующих программно-аппаратных средств (системы обнару-

жения атак, межсетевые экраны, сканеры уязвимости и т.п.) в целом

являются довольно ограниченными и, в силу указанных выше при-

чин, не позволяют решать поставленные задачи в полном объеме.

Возможный выход из сложившейся ситуации состоит в приме-

нении известного в кибернетике принципа «необходимого разнообра-

зия» У. Р. Эшби [2], суть которого заключается в том, что для ус-

пешного функционирования системы сложность ее управляющей

части (т.е. многообразие выполняемых ею функций и методов их реа-

лизации) должна соответствовать сложности управляемого объекта и

той среды, в которой он функционирует. Применительно к сфере

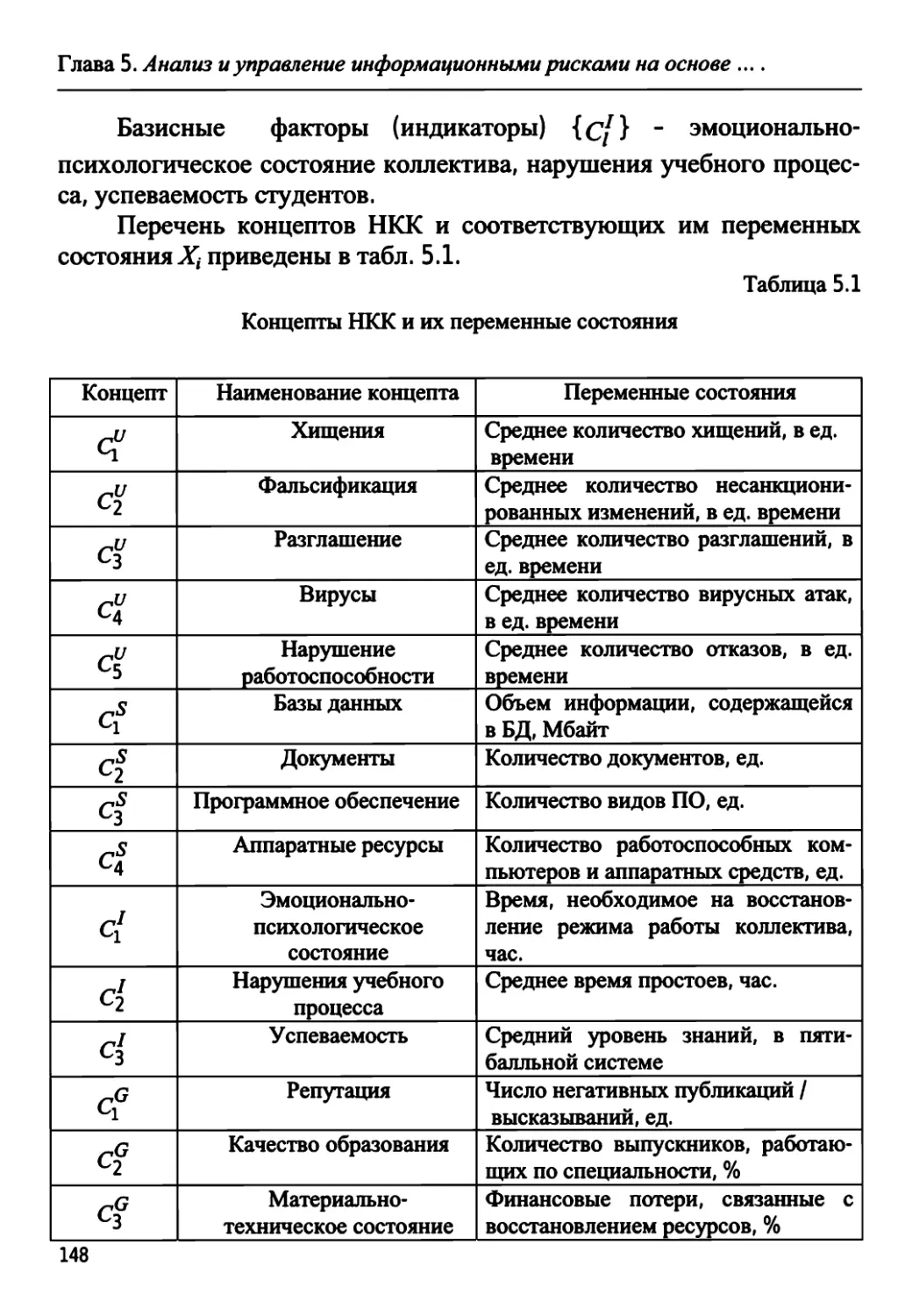

информационной безопасности, это означает, что защита должна

быть адекватна нападению, т.е. используемые средства защиты ин-

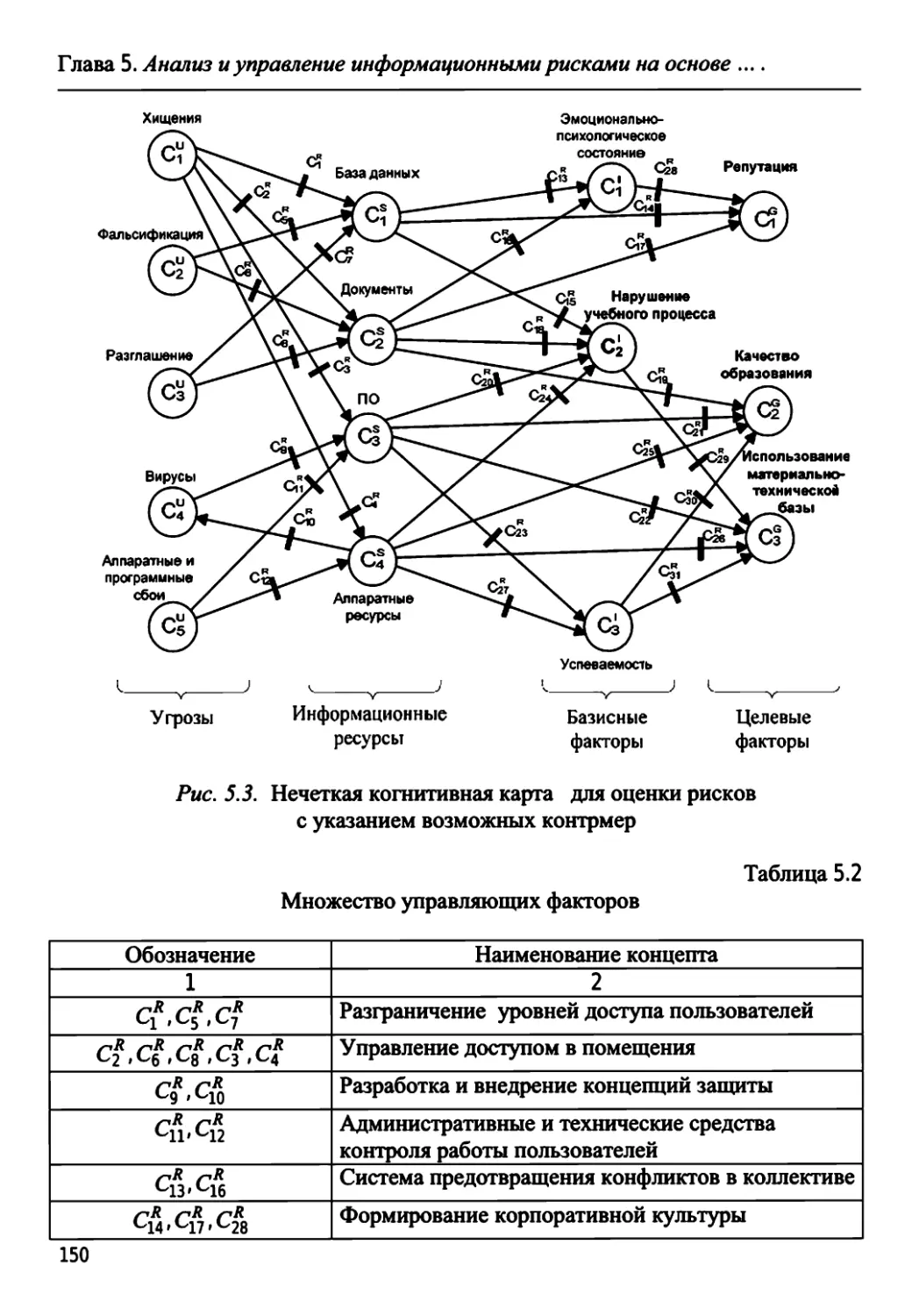

формации должны обеспечить своевременное обнаружение и досто-

верное распознавание различных видов угроз с учетом возможного

места и характера их проявления, квалификации злоумышленника,

потенциальных уязвимостей информационной системы и т.д., а также

предотвращение или локализацию воздействия этих угроз на защи-

щаемую информацию в условиях действия указанных выше факторов

неопределенности.

В последние годы большое внимание специалистов привлекает

направление, связанное с интеллектуализацией систем защиты ин-

6

Введение

формации, т.е. с наделением их такими функциями, которые обычно

выполняет высококвалифицированный оператор (эксперт), привлекая

для этого свои профессиональные знания и опыт. Решаемые им зада-

чи в процессе выполнения этих функций относятся к классу плохо-

формализуемых (неструктурированных) задач, составляющих пред-

мет изучения и применения методов искусственного интеллекта.

Существуют различные определения искусственного интеллекта

(ИИ). По мнению профессора Массачусетского технологического ин-

ститута (США) Марвина Мински, одного из пионеров ИИ, искусст-

венный интеллект (англ. - Artificial Intelligence) - это «наука, которая

позволяет машинам делать такие вещи, которые при их выполнении

людьми требуют интеллекта». Известный французский ученый Жан

Луи Лорьер в своей книге [3] дает более развернутое определение:

искусственный интеллект - это «область исследований, в которой

главным желанием исследователей является стремление понять, как

система обработки информации, будь то человек или машина - спо-

собна воспринимать, анализировать, передавать и обобщать то, чему

ее обучают, и с помощью этих данных исследовать конкретные си-

туации и находить решения задач».

Область исследований искусственного интеллекта чрезвычайно

широка и охватывает такие направления /методы, как:

• искусственные нейронные сети (НС);

• системы на основе нечеткой логики (НЛ);

• генетические алгоритмы (ГА);

• экспертные системы (ЭС);

• мультиагентные системы (MAC);

• искусственные иммунные системы (ИИС).

Не останавливаясь подробно на содержании указанных направ-

лений (более детальную информацию читатель может найти, напри-

мер, в [3 - 10]), рассмотрим ниже лишь те из задач, относящиеся к

области защиты информации (естественно, это далеко не полный их

перечень!), которые эффективно решаются с помощью указанных ме-

тодов для обеспечения эффективной защиты информации в условиях

неопределенности. Поскольку затронутая проблема является очень

обширной, авторы были вынуждены ограничиться рассмотрением

лишь некоторых «узловых точек» этой проблемы, с целью привлечь

7

Введение

внимание читателя к данной проблематике и пробудить в нем интерес

к более глубокому ее изучению. В основу пособия положен анализ

большого числа источников, на которые по тексту сделаны ссылки,

включая труды общепризнанных авторов в области ИИ, а также со-

временные научные публикации, в том числе принадлежащие автору.

Изложение сопровождается большим числом примеров (часть из ко-

торых носит оригинальный характер), иллюстрирующих особенно-

сти реализации соответствующих методов ИИ в системах защиты

информации.

Для того чтобы не перегружать основной текст множеством оп-

ределений, автор рекомендует читателям обратиться к

ГОСТ Р 50922-2006 «Защита информации. Основные термины и оп-

ределения» (см. также [11]).

Учебное пособие предназначено для слушателей и студентов,

обучающихся по специализации специальности «Комплексное обес-

печение информационной безопасности автоматизированных сис-

тем», а также преподавателям при проведении лекционных и индиви-

дуальных занятий по курсу «Искусственный интеллект в системах

защиты информации». Материалы, изложенные в пособии, могут

быть также полезны аспирантам, научным работникам и специали-

стам при проведении научных исследований и в практической работе.

8

Глава 1. Основы построения интеллектуальных систем защиты информации

ГЛАВА 1. ОСНОВЫ ПОСТРОЕНИЯ ИНТЕЛЛЕКТУАЛЬНЫХ

СИСТЕМ ЗАЩИТЫ ИНФОРМАЦИИ

L1. Системные принципы защиты информации

Под термином информационная безопасность (ИБ) понимается

отсутствие недопустимого риска, связанного с причинением прямого

или косвенного имущественного (финансового) ущерба предприятию

(организации), который вызван нарушением конфиденциальности,

целостности и доступности информации.

Сегодня состояние ИБ становится одним из рейтинговых пока-

зателей, отражающих надежность и устойчивость работы предпри-

ятия. Обеспечение ИБ предполагает проведение организационных

(административных), технических, юридических и других мероприя-

тий, направленных на предупреждение, отражение, ликвидацию все-

возможных видов угроз функционированию информационной струк-

туры предприятия, минимизацию или поддержание на некотором до-

пустимом уровне рисков, а также минимизацию возможного ущерба,

возникшего при реализации этих задач. При этом под угрозой ин-

формационной безопасности понимается наличие потенциальной

возможности использования некоторой информации или воздействия

на эту информацию, ведущей к прямому или косвенному ущербу для

предприятия.

С целью обеспечения заданного уровня ИБ на предприятии соз-

дается комплексная система защиты информации, в основу построе-

ния которой закладываются следующие системные принципы [12,

13]:

• принцип системного подхода - предполагает необходимость

учета всех взаимосвязанных, взаимодействующих и изменяющихся

во времени компонентов, условий и факторов, существенных для

обеспечения безопасного функционирования информационной сис-

темы (ИС);

• принцип комплексности - означает согласованное примене-

ние разнородных средств и мероприятий для обеспечения безопасно-

сти всей совокупности информации, подлежащей защите, по отноше-

нию ко всему спектру угроз;

9

Глава 1. Основы построения интеллектуальных систем защиты информации

• принцип адекватности - принимаемые решения должны вы-

бираться таким образом, чтобы обеспечить необходимый уровень ИБ

при минимальных затратах на создание механизмов защиты и обес-

печение их правильного функционирования;

• принцип адаптивности - система защиты информации

должна строиться с учетом возможного изменения конфигурации се-

ти, числа пользователей и степени конфиденциальности и ценности

информации. При этом введение каждого нового элемента сети или

изменение действующих условий не должно снижать достигнутого

уровня защищенности ИС;

• принцип неопределенности - должна обеспечиваться эффек-

тивная защита информации в условиях неопределенности действия

угроз, влияния человеческого фактора, отсутствия формальных мате-

матических моделей для описания информационных процессов и

технологий и т.д.;

• принцип непрерывности - защита информации представляет

собой непрерывный целенаправленный процесс, предполагающий

принятие соответствующих мер на всех этапах жизненного цикла ИС.

В [14, 15] в качестве важных методологических принципов, от-

носящихся к процессу изучения сложных проблем защиты информа-

ции и практической реализации результатов этого изучения, отмеча-

ются следующие принципы:

• построение адекватных моделей изучаемых систем и про-

цессов - необходима разработка методов, позволяющих адекватно

моделировать системы и процессы, существенно зависящие от воз-

действия случайных и труднопредсказуемых факторов. Попытки мо-

делирования таких систем с использованием традиционных методов

часто приводят к тому, что создаваемые модели оказываются неаде-

кватными моделируемым системам. Возможный выход из сложивше-

гося положения заключается в применении методов теории нечетких

множеств, лингвистических переменных (нестандартной математи-

ки), неформального оценивания, неформального поиска оптимальных

решений;

• унификация разрабатываемых решений - требуется разра-

ботка некоторой унифицированной концепции построения сложных

систем, позволяющей представить решение проблемной ситуации

10

Глава 1. Основы построения интеллектуальных систем защиты информации

«объект - среда - цели» в виде последовательности самостоятельных,

относительно независимых проектных задач (этапов) и, в конечном

итоге, свести решение задачи проектирования к выбору типовых и

стандартных проектных решений;

• максимальная структуризация изучаемых систем и разра-

батываемых решений - предполагает декомпозицию сложной сис-

темы и элементов ее среды на отдельные составляющие (компонен-

ты), взаимодействующие друг с другом, анализ которых позволяет в

конечном итоге сформировать такую архитектуру разрабатываемой

системы, которая наилучшим образом удовлетворяет всей совокупно-

сти условий проектирования, эксплуатации и усовершенствования;

• радикальная эволюция в реализации разработанных пред-

ложений - суть этого принципа, сформулированного академиком

В. М. Глушковым еще в 70-х годах прошлого столетия, заключается

в том, что необходимо стремиться к радикальным совершенствовани-

ям, связанным с кардинальными улучшениями архитектуры систем и

процессов их организации и обеспечения функционирования, однако,

с учетом практических соображений, реализовывать их следует по-

степенно, эволюционным путем.

Очевидно, что список перечисленных выше принципов можно

продолжить (хотя, как было замечено в дискуссии на одной из науч-

ных конференций, «... более трех принципов - это уже беспринцип-

ность»). Тем не менее, главный вывод, вытекающий из существа этих

принципов, состоит в следующем. Современная система защиты ин-

формации (СЗИ) - это сложная, динамическая, развивающаяся чело-

веко-машинная система, неотделимая от объекта защиты -

информационной системы предприятия (организации) и призванная

обеспечить его нормальное и устойчивое функционирование в усло-

виях действия возможных внутренних и внешних угроз. Эти угрозы

характеризуются существенной неопределенностью, что требует ис-

пользования для их описания, а равно, и для построения соответст-

вующих алгоритмов принятия решений в СЗИ, адекватных этим уг-

розам, математических моделей и методов искусственного интеллек-

та. Конкретная реализация этих моделей, методов и алгоритмов опре-

деляется характером угроз, спецификой решаемых задач по защите

информации, требованиями к уровню защищенности ИС.

11

Глава 1. Основы построения интеллектуальных систем защиты информации

1.2. Интегрированные системы защиты информации

Поскольку проблема обеспечения ИБ является комплексной и

многоплановой, то для ее решения обычно используется широкий

спектр различных по своей природе средств и мероприятий.

Различают следующие уровни обеспечения ИБ [16]:

• нормативно-законодательный;

• административный;

• процедурный;

• программно-технический.

На нормативно-законодательном уровне разрабатываются за-

конодательные меры обеспечения ИБ, регулирующие информацион-

ные отношения между различными субъектами (юридическими и фи-

зическими лицами) в пределах страны. В нашей стране в данной об-

ласти в течение последних лет приняты к исполнению «Доктрина ин-

формационной безопасности», Федеральные законы «Об информа-

ции, информационных технологиях и защите информации», «О госу-

дарственной тайне», «О коммерческой тайне», «О персональных

данных» и др. К числу нормативных документов, действующих в на-

стоящее время в Российской Федерации и определяющих норматив-

но-техническую базу в области ИБ, относятся такие национальные

стандарты (разработанные на основе соответствующих международ-

ных стандартов), как ГОСТ Р ИСО/МЭК 15408, 17799, 27001, 13335

[17].

К административному уровню ИБ относятся действия общего

характера, предпринимаемые руководством предприятия. Главная

цель административного уровня - сформировать программу работ в

области ИБ и обеспечить ее выполнение, выделяя необходимые ре-

сурсы и контролируя состояние дел. Основой этой программы явля-

ется политика безопасности, которая строится на основе анализа рис-

ков и отражает принятый подход к защите информационных ресурсов

предприятия.

На процедурном уровне ИБ применяются главным образом орга-

низационные меры безопасности, ориентированные на людей, а не на

технические средства. К данным мерам относятся: управление персо-

налом; физическая защита; поддержание работоспособности инфор-

12

Глава 1. Основы построения интеллектуальных систем защиты информации

мационной системы; реагирование на нарушения режима безопасно-

сти; планирование восстановительных работ (в случае возникновения

серьезных аварий). В качестве нормативно-методической базы ИБ

здесь выступают так называемые специализированные политики ИБ

(по конкретным аспектам ИБ), правила и процедуры ИБ, инструкции

администраторам и пользователям ИС.

И наконец, программно-технический уровень ИБ - это уровень,

на котором реализуются различные программно-технические меры,

направленные на контроль работоспособности оборудования и про-

граммного обеспечения. Поскольку из общего числа угроз в послед-

ние годы все больший удельный вес занимают внутренние угрозы со

стороны персонала, по отношению к которым процедурные меры не

дают большого эффекта, именно на программно-технические меры

возлагаются большие надежды в силу, прежде всего, большого раз-

нообразия выполняемых ими функций и способов их реализации.

Одним из центральных понятий для программно-технического

уровня является понятие сервиса (функции безопасности) . Наиболее

распространенными сервисами безопасности являются:

• идентификация и аутентификация;

• управление доступом;

• протоколирование и аудит;

• шифрование;

• контроль целостности;

• экранирование;

• анализ защищенности;

• обеспечение отказоустойчивости;

• обеспечение безопасного восстановления;

• туннелирование;

• управление.

Не вдаваясь в подробности относительно содержания каждого

из перечисленных сервисов (подробную информацию по этому во-

просу можно найти, например, в [16]), отметим лишь, что некоторые

1 Предполагается, что основные функции, выполняемые информационной

системой, относятся к ее основным сервисам. Сервисы безопасности относятся

к группе вспомогательных сервисов (функций) системы.

13

Глава 1. Основы построения интеллектуальных систем защиты информации

из этих сервисов будут детально рассмотрены в последующих главах

данного пособия, выступая в качестве «площадки» для реализации

соответствующих функций защиты с помощью методов искусствен-

ного интеллекта.

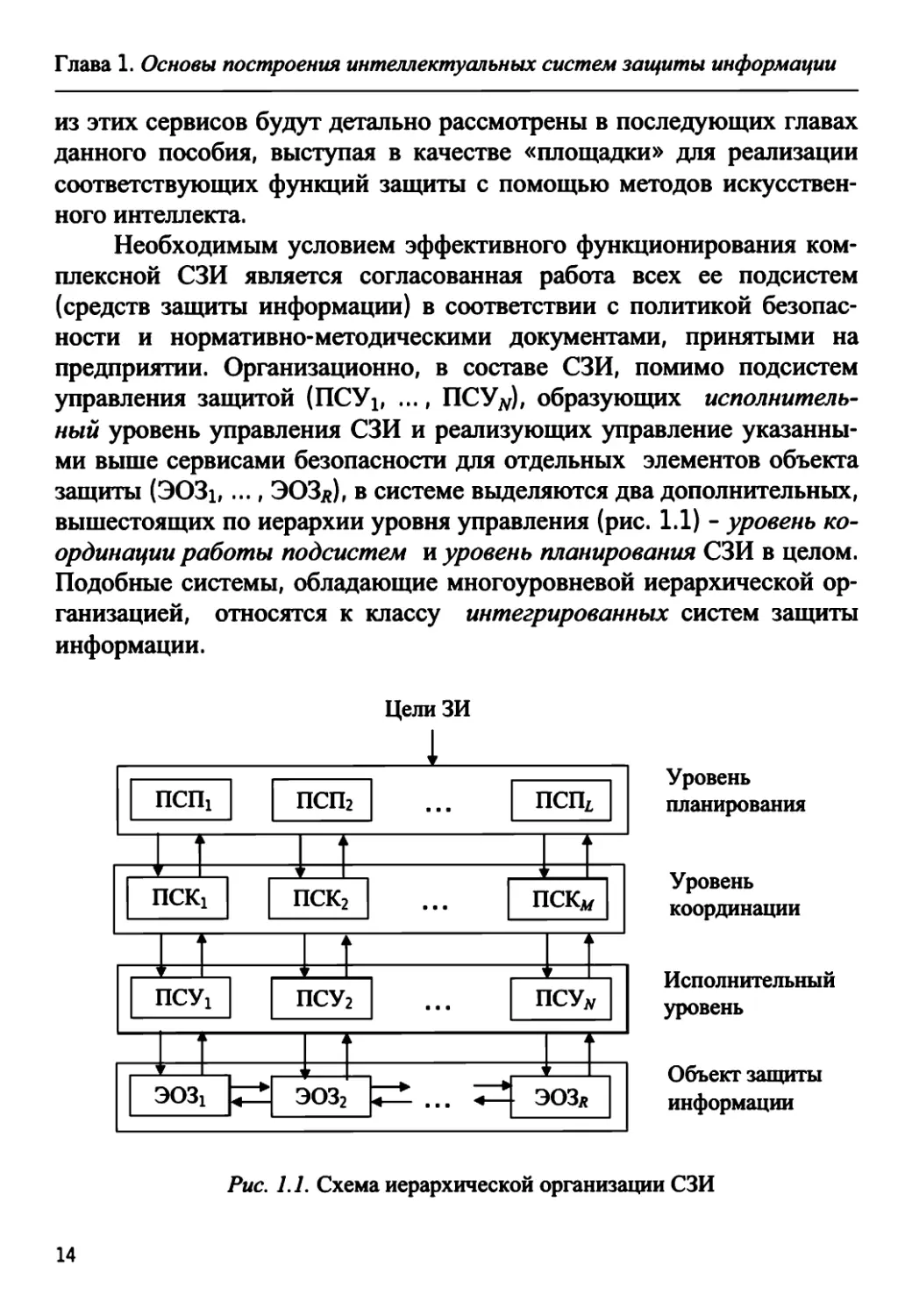

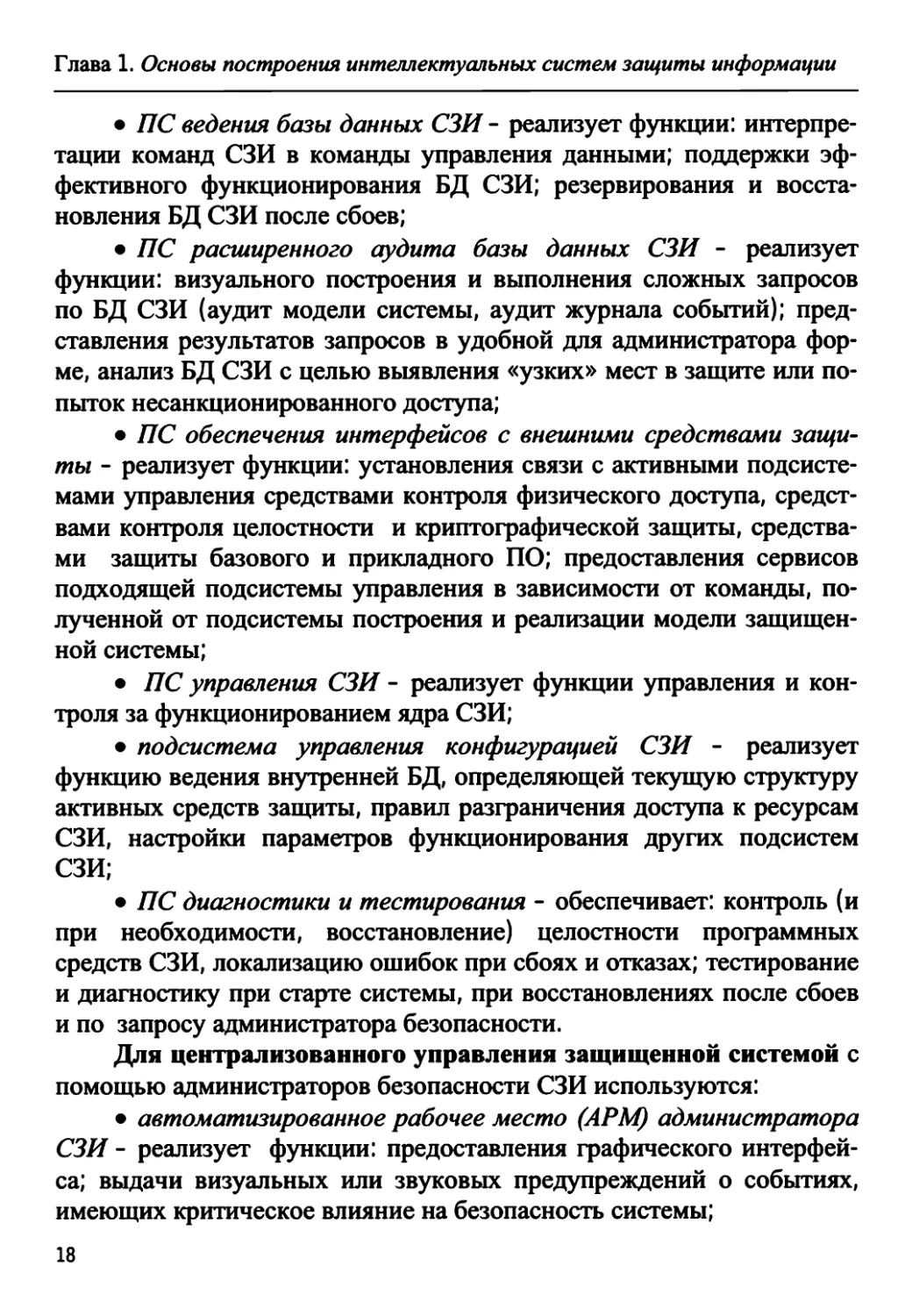

Необходимым условием эффективного функционирования ком-

плексной СЗИ является согласованная работа всех ее подсистем

(средств защиты информации) в соответствии с политикой безопас-

ности и нормативно-методическими документами, принятыми на

предприятии. Организационно, в составе СЗИ, помимо подсистем

управления защитой (ПСУх, ..., ПСУ#), образующих исполнитель-

ный уровень управления СЗИ и реализующих управление указанны-

ми выше сервисами безопасности для отдельных элементов объекта

защиты (303i, ..., ЭОЗд), в системе выделяются два дополнительных,

вышестоящих по иерархии уровня управления (рис. 1.1) - уровень ко-

ординации работы подсистем и уровень планирования СЗИ в целом.

Подобные системы, обладающие многоуровневой иерархической ор-

ганизацией, относятся к классу интегрированных систем защиты

информации.

ЦелиЗИ

11 псщ

1

1

f

псп2

i 1

| ПСК1

1 \

i

7

1

1

г

I

■ • ■

псщ |

i

пск2

i

\ | ПСУ1

1 1

i

г

ч

• • •

i

J

г

k

ПСКлг | 1

1 т

^ 1

ПСУ2

I

| |~ 303i

<—

1

i

^

■ ■ ■

у

i

7

i

ПСУ* |

i

эоз2

4 . . . 4

1

i

г

i

■ ЭОЗл | 1

Уровень

планирования

Уровень

координации

Исполнительный

уровень

Объект защиты

информации

Рис. 1.1. Схема иерархической организации СЗИ

14

Глава 1. Основы построения интеллектуальных систем защиты информации

Уровень координации данной системы, называемый также

«ядром» СЗИ, реализует функции координированного управления

работой подсистем защиты и включает в себя ряд подсистем управ-

ления (IlCKi,..., ПСКд/), обеспечивающих [15]:

• включение в работу компонентов (подсистем) СЗИ при по-

ступлении запросов на обработку защищаемых данных;

• управление работой СЗИ в процессе обработки защищаемых

данных;

• организацию и обеспечение проверок правильности функ-

ционирования СЗИ;

• блокирование несанкционированного доступа (НСД) к защи-

щаемым базам данных;

• обеспечение реагирования на сигналы о несанкционирован-

ных действиях;

• ведение протоколов СЗИ и др.

На уровень планирования СЗИ, также состоящий из нескольких

подсистем планирования (ПСЩ, ..., ПСПх,), возлагаются функции

контроля состояния безопасности информационной системы. Здесь

выполняются такие важные функции, как:

• контроль текущего уровня защищенности ИС;

• слежение за опасными ситуациями (непредвиденными об-

стоятельствами) ;

• анализ причин, которые привели к их возникновению, и уст-

ранение последствий;

• прогноз развития ситуаций;

• анализ рисков;

• перераспределение ресурсов (задача выбора оптимального на-

бора средств защиты) при изменении состава ИС или характеристик

среды.

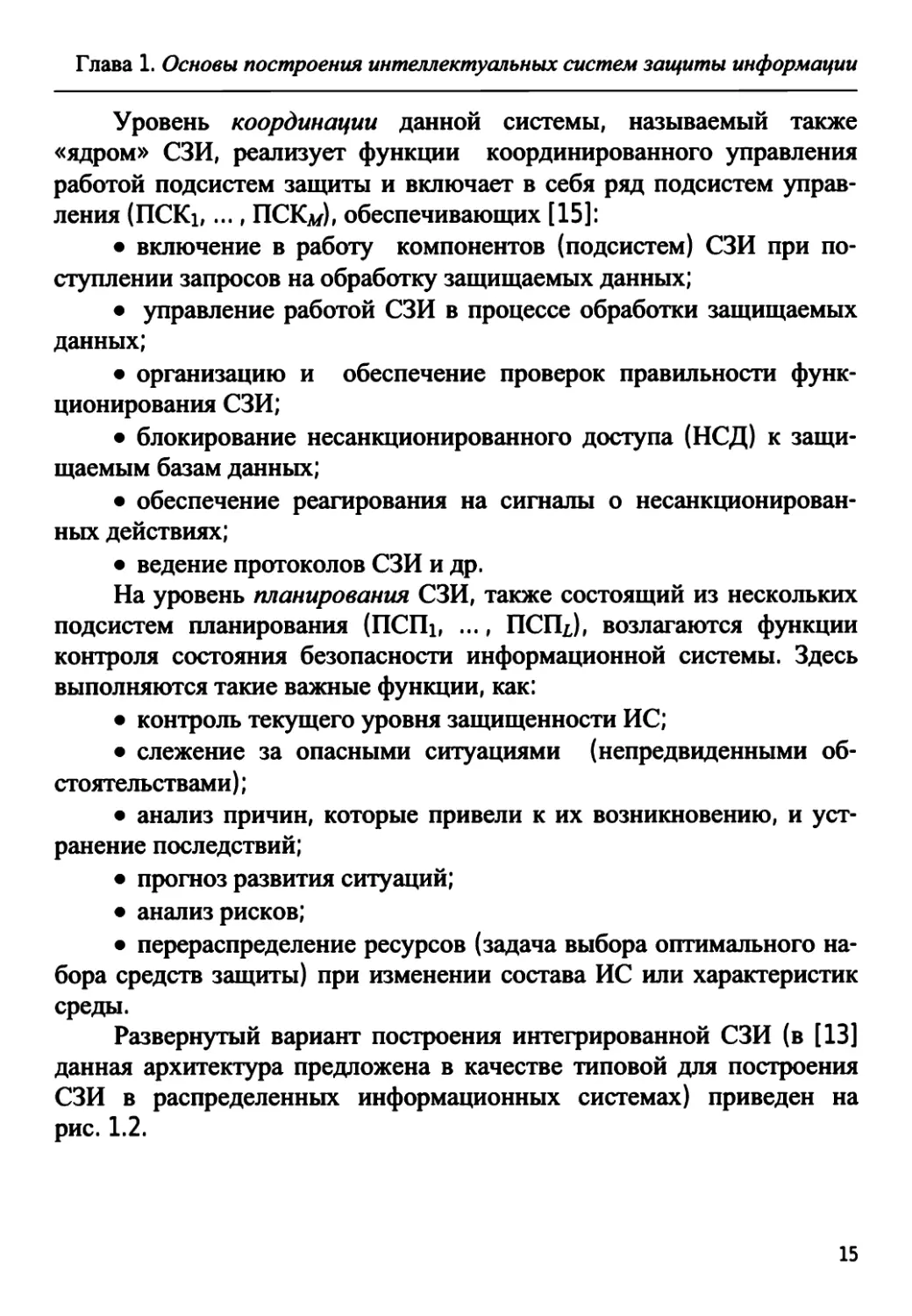

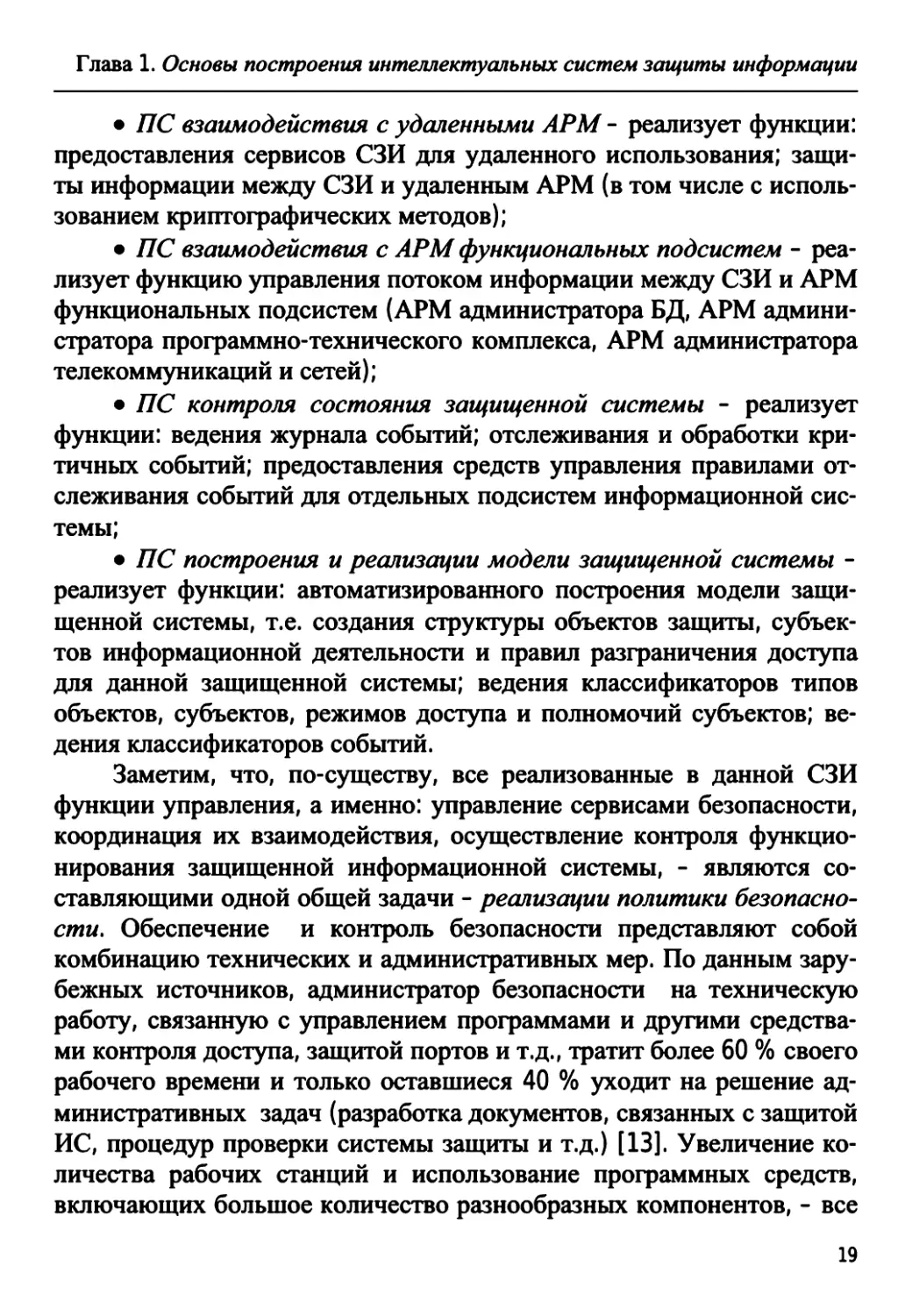

Развернутый вариант построения интегрированной СЗИ (в [13]

данная архитектура предложена в качестве типовой для построения

СЗИ в распределенных информационных системах) приведен на

рис. 1.2.

15

ПС взаимодействия с АРМ

функциональных подсистем

i

ПС взаимодействия

с удаленными АРМ СЗИ

АРМ администратора безопасности

Я

F

Удаленный АРМ

администратора безопасности

ПС контроля состояния защищенной системы

ПС построения и реализации модели защищенной системы

п

1

Ядро системы защиты информации

ПС расширенного аудита базы

данных СЗИ

i

ПС контроля доступа к сервисам СЗИ

п

ПС ведения базы данных СЗИ

—~г

ПС управления транзакциями

I База данных СЗИ I

ПС обеспечения интерфейсов

с внешними средствами защиты

fi

ПС управления конфигурацией

СЗИ

ПС управления СЗИ

ПС диагностики и тестирования

ПС управления

средствами

идентификации

и аутентификации

ПС обеспечения

целостности

и конфиденциальности

ПС управления

средствами

защиты базового

ПО

ПС управления

средствами

защиты

прикладного ПО

1

ПС управления

средствами контроля

физического доступа

Рис. 1.2. Архитектура интегрированной системы защиты информации

Глава 1. Основы построения интеллектуальных систем защиты информации

В этой системе для реализации функций управления базо-

выми сервисами безопасности используются следующие подсисте-

мы (ПС):

• ПС управления средствами идентификации и аутентифика-

ции - обеспечивает управление сервисами идентификации и аутен-

тификации, реализуемыми в СЗИ, включая средства идентификации

и аутентификации базового или прикладного программного обеспе-

чения (ПО);

• ПС обеспечения целостности и конфиденциальности - реали-

зует функции: управления доступом к ресурсам информационной

системы; управления сервисами контроля и восстановления целост-

ности, а также криптографических преобразований;

• ПС управления средствами защиты базового ПО - реализует

функции: интерпретации команд СЗИ в команды управления средст-

вами защиты базового ПО; прием и обработку сообщений о событиях

от средств защиты базового ПО;

• ПС управления средствами защиты прикладного ПО - реали-

зует функции: интерпретации команд СЗИ в команды управления

средствами защиты прикладного ПО; прием и обработку сообщений

о событиях от средств защиты прикладного ПО;

• ПС управления средствами контроля физического доступа -

реализует функции: интерпретации команд СЗИ в команды управле-

ния средствами контроля физического доступа; прием и обработку

сообщений от средств контроля физического доступа.

Для координации взаимодействия различных подсистем в

составе СЗИ используются следующие подсистемы:

• ПС контроля доступа к сервисам СЗИ - реализует функции

генерации сеансовых ключей при подключении к серверу СЗИ, кон-

троля полномочий администраторов на выполнение команд управле-

ния процессом защиты и ведения базы данных (БД) полномочий ад-

министраторов;

• ПС управления транзакциями - реализует функции поддержки

транзакционной модели выполнения команд СЗИ - команда считает-

ся выполненной, если выполнены все составляющие ее операции; в

противном случае система должна быть возвращена в исходное со-

стояние;

17

Глава 1. Основы построения интеллектуальных систем защиты информации

• ПС ведения базы данных СЗИ - реализует функции: интерпре-

тации команд СЗИ в команды управления данными; поддержки эф-

фективного функционирования БД СЗИ; резервирования и восста-

новления БД СЗИ после сбоев;

• ПС расширенного аудита базы данных СЗИ - реализует

функции: визуального построения и выполнения сложных запросов

по БД СЗИ (аудит модели системы, аудит журнала событий); пред-

ставления результатов запросов в удобной для администратора фор-

ме, анализ БД СЗИ с целью выявления «узких» мест в защите или по-

пыток несанкционированного доступа;

• ПС обеспечения интерфейсов с внешними средствами защи-

ты - реализует функции: установления связи с активными подсисте-

мами управления средствами контроля физического доступа, средст-

вами контроля целостности и криптографической защиты, средства-

ми защиты базового и прикладного ПО; предоставления сервисов

подходящей подсистемы управления в зависимости от команды, по-

лученной от подсистемы построения и реализации модели защищен-

ной системы;

• ПС управления СЗИ - реализует функции управления и кон-

троля за функционированием ядра СЗИ;

• подсистема управления конфигурацией СЗИ - реализует

функцию ведения внутренней БД, определяющей текущую структуру

активных средств защиты, правил разграничения доступа к ресурсам

СЗИ, настройки параметров функционирования других подсистем

СЗИ;

• ПС диагностики и тестирования - обеспечивает: контроль (и

при необходимости, восстановление) целостности программных

средств СЗИ, локализацию ошибок при сбоях и отказах; тестирование

и диагностику при старте системы, при восстановлениях после сбоев

и по запросу администратора безопасности.

Для централизованного управления защищенной системой с

помощью администраторов безопасности СЗИ используются:

• автоматизированное рабочее место (АРМ) администратора

СЗИ - реализует функции: предоставления графического интерфей-

са; выдачи визуальных или звуковых предупреждений о событиях,

имеющих критическое влияние на безопасность системы;

18

Глава 1. Основы построения интеллектуальных систем защиты информации

• ПС взаимодействия с удаленными АРМ - реализует функции:

предоставления сервисов СЗИ для удаленного использования; защи-

ты информации между СЗИ и удаленным АРМ (в том числе с исполь-

зованием криптографических методов);

• ПС взаимодействия с АРМ функциональных подсистем - реа-

лизует функцию управления потоком информации между СЗИ и АРМ

функциональных подсистем (АРМ администратора БД, АРМ админи-

стратора программно-технического комплекса, АРМ администратора

телекоммуникаций и сетей);

• ПС контроля состояния защищенной системы - реализует

функции: ведения журнала событий; отслеживания и обработки кри-

тичных событий; предоставления средств управления правилами от-

слеживания событий для отдельных подсистем информационной сис-

темы;

• ПС построения и реализации модели защищенной системы -

реализует функции: автоматизированного построения модели защи-

щенной системы, т.е. создания структуры объектов защиты, субъек-

тов информационной деятельности и правил разграничения доступа

для данной защищенной системы; ведения классификаторов типов

объектов, субъектов, режимов доступа и полномочий субъектов; ве-

дения классификаторов событий.

Заметим, что, по-существу, все реализованные в данной СЗИ

функции управления, а именно: управление сервисами безопасности,

координация их взаимодействия, осуществление контроля функцио-

нирования защищенной информационной системы, - являются со-

ставляющими одной общей задачи - реализации политики безопасно-

сти. Обеспечение и контроль безопасности представляют собой

комбинацию технических и административных мер. По данным зару-

бежных источников, администратор безопасности на техническую

работу, связанную с управлением программами и другими средства-

ми контроля доступа, защитой портов и т.д., тратит более 60 % своего

рабочего времени и только оставшиеся 40 % уходит на решение ад-

министративных задач (разработка документов, связанных с защитой

ИС, процедур проверки системы защиты и т.д.) [13]. Увеличение ко-

личества рабочих станций и использование программных средств,

включающих большое количество разнообразных компонентов, - все

19

Глава 1. Основы построения интеллектуальных систем защиты информации

это приводит к такой ситуации, когда администратор безопасности

уже физически оказывается не в состоянии оперативно анализировать

огромный объем сведений, содержащихся в журнале регистрации со-

бытий СЗИ. Это особенно важно в условиях, когда на повестку дня

ставится задача реализации упреждающей стратегии защиты, в со-

ответствии с которой необходимо обеспечить требуемый уровень

защищенности ИС в условиях воздействия на нее не только уже из-

вестных (т.е. ранее проявлявшихся) или наиболее опасных угроз, но

и от всех потенциально возможных (в том числе априорно неизвест-

ных) угроз на ИС.

Таким образом, несмотря на очевидные преимущества интегри-

рованных СЗИ - возможность централизованного управления рабо-

той всех подсистем практически с одного пульта (консоли), коорди-

нация и контроль правильности функционирования этих подсистем,

минимизация избыточности (устранение дублирования функций), уп-

рощение механизмов оценки ситуаций и принятия решений, им при-

сущ ряд недостатков. В качестве таких недостатков можно отметить,

прежде всего, их недостаточную гибкость (возможные ошибочные

реакции при появлении неизвестных угроз, затруднения при оценке

сложных ситуаций, снижение оперативности принятия решений при

большом числе дестабилизирующих факторов - так называемое

«проклятие размерности»), повышенная нагрузка на администратора

безопасности, возможные «нестыковки» механизмов защиты (алго-

ритмов реализации сервисов безопасности) при использовании тех-

нических решений различных фирм-производителей и т.д.

Подобные затруднения в значительной степени теряют свою

остроту в связи с появлением нового класса СЗИ - адаптивных ин-

тегрированных (интеллектуальных) систем защиты информации,

идея построения которых представлена ниже.

1.3. Интеллектуализация систем защиты информации

Под интеллектуализацией СЗИ будем понимать повышение ее

интеллектуальных возможностей с целью обеспечения высокого

уровня её автономности, адаптивности и надежности в условиях не-

определенности. Это предполагает передачу компьютеру максималь-

но возможного количества функций по сбору, обработке информации

20

Глава 1. Основы построения интеллектуальных систем защиты информации

и принятию решений для того, чтобы помочь пользователям и адми-

нистраторам системы получить более объективную оценку событий,

происходящих на объекте (в системе), и принять правильные и свое-

временные решения. В качестве средства борьбы с неопределенно-

стью (НЕ-факторами) в данном случае выступают методы и техноло-

гии искусственного интеллекта.

Заметим, что в отношении точного определения ИИ, его воз-

можностей и перспектив в последние годы не прекращаются споры.

Так, известный специалист в области ИИ Джордж Ф. Люггер в своей

книге [4] пишет: «Проблема определения искусственного интеллекта

сводится к проблеме определения интеллекта вообще: является ли он

чем-то единым, или этот термин объединяет набор разрозненных

способностей? В какой мере интеллект можно создать, а в какой он

существует априори? Что именно происходит при таком создании?...

Можно ли судить о наличии интеллекта только по наблюдаемому по-

ведению, или же требуется свидетельство наличия некого скрытого

механизма? Как представляются знания в нервных тканях живых су-

ществ, и как можно применить это в проектировании интеллектуаль-

ных устройств? ... И более того, необходимо ли создавать интеллек-

туальную компьютерную программу по образу и подобию человече-

ского разума, или же достаточно строго «инженерного» подхода?...

На эти вопросы ответа пока не найдено, но все они помогли сформи-

ровать задачи и методологии, составляющие основу современного

ИИ. Отчасти, привлекательность искусственного интеллекта в том и

состоит, что он является оригинальным и мощным орудием для ис-

следования именно этих проблем. ИИ представляет средство и испы-

тательную модель для теорий интеллекта: такие теории могут быть

переформулированы на языке компьютерных программ, а затем ис-

пытаны при их выполнении».

Термин «интеллектуальная система» также пока не получил об-

щепринятого определения. Как правило, считается, что интеллекту-

альная система характеризуется наличием одного или нескольких из

перечисленных ниже свойств:

• адаптивность;

• способность к обучению и самообучению;

• совершение «правильных действий»;

21

Глава 1. Основы построения интеллектуальных систем защиты информации

• ориентированность на определенную цель;

• использование знаний в процессе обучения и функциониро-

вания.

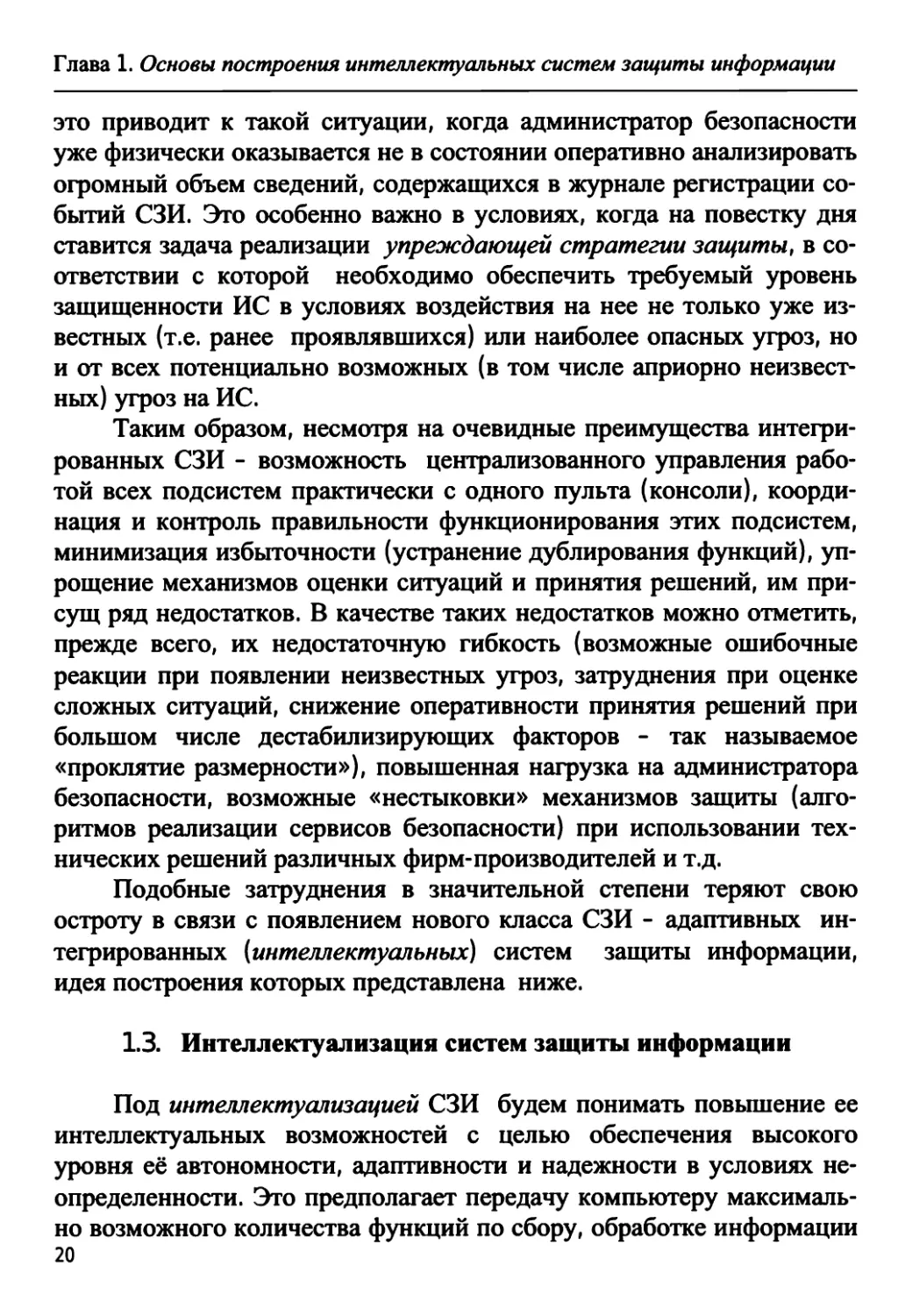

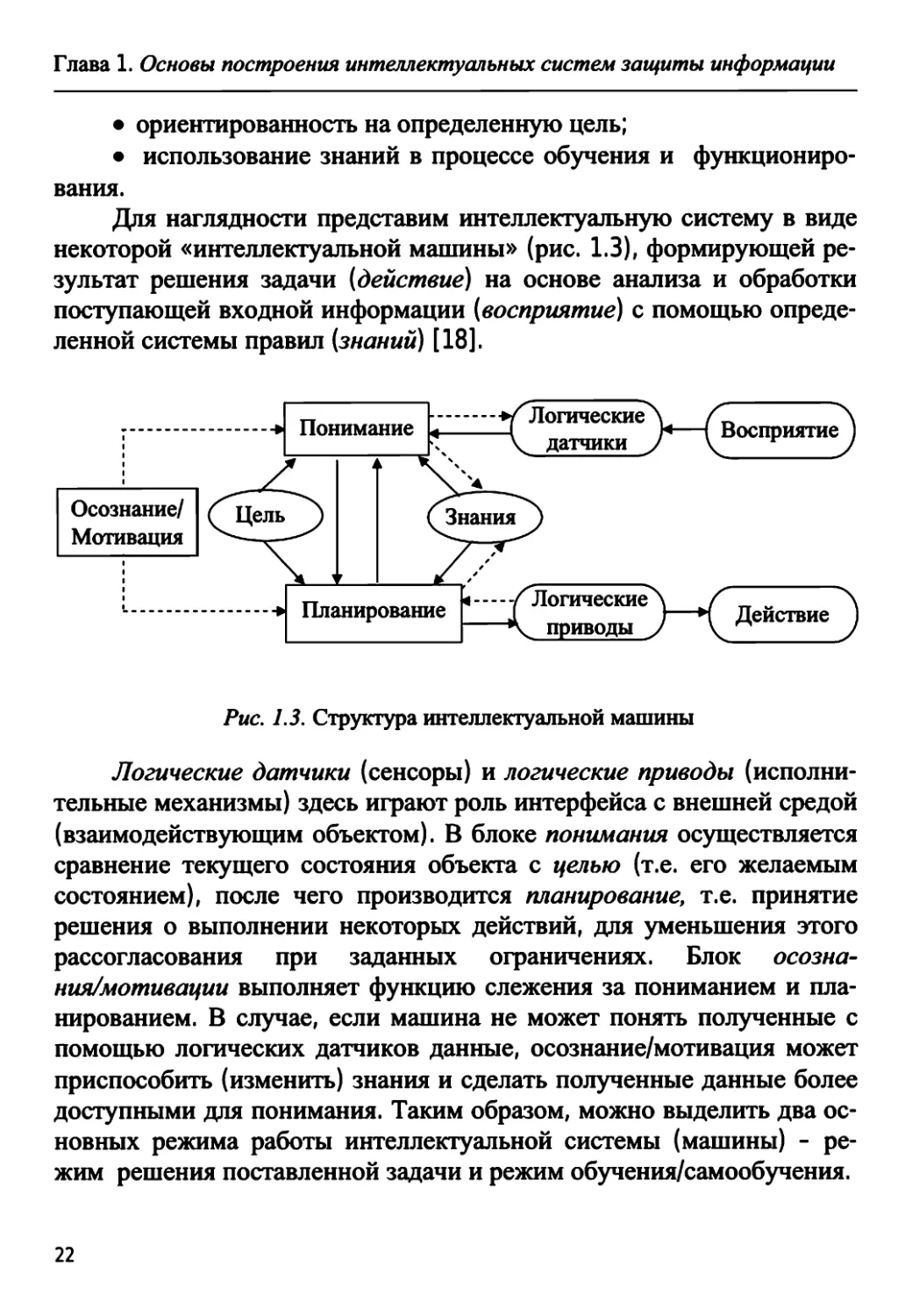

Для наглядности представим интеллектуальную систему в виде

некоторой «интеллектуальной машины» (рис. 1.3), формирующей ре-

зультат решения задачи (действие) на основе анализа и обработки

поступающей входной информации (восприятие) с помощью опреде-

ленной системы правил (знаний) [18].

-И Понимание

Осознание/

Мотивация

L _

Планирование

Логические

датчики

Восприятие

о

Логические

приводы

Л / \

' )—Н Действие J

Рис. 1.3. Структура интеллектуальной машины

Логические датчики (сенсоры) и логические приводы (исполни-

тельные механизмы) здесь играют роль интерфейса с внешней средой

(взаимодействующим объектом). В блоке понимания осуществляется

сравнение текущего состояния объекта с целью (т.е. его желаемым

состоянием), после чего производится планирование, т.е. принятие

решения о выполнении некоторых действий, для уменьшения этого

рассогласования при заданных ограничениях. Блок осозна-

ния/мотивации выполняет функцию слежения за пониманием и пла-

нированием. В случае, если машина не может понять полученные с

помощью логических датчиков данные, осознание/мотивация может

приспособить (изменить) знания и сделать полученные данные более

доступными для понимания. Таким образом, можно выделить два ос-

новных режима работы интеллектуальной системы (машины) - ре-

жим решения поставленной задачи и режим обучения/самообучения.

22

Глава 1. Основы построения интеллектуальных систем защиты информации

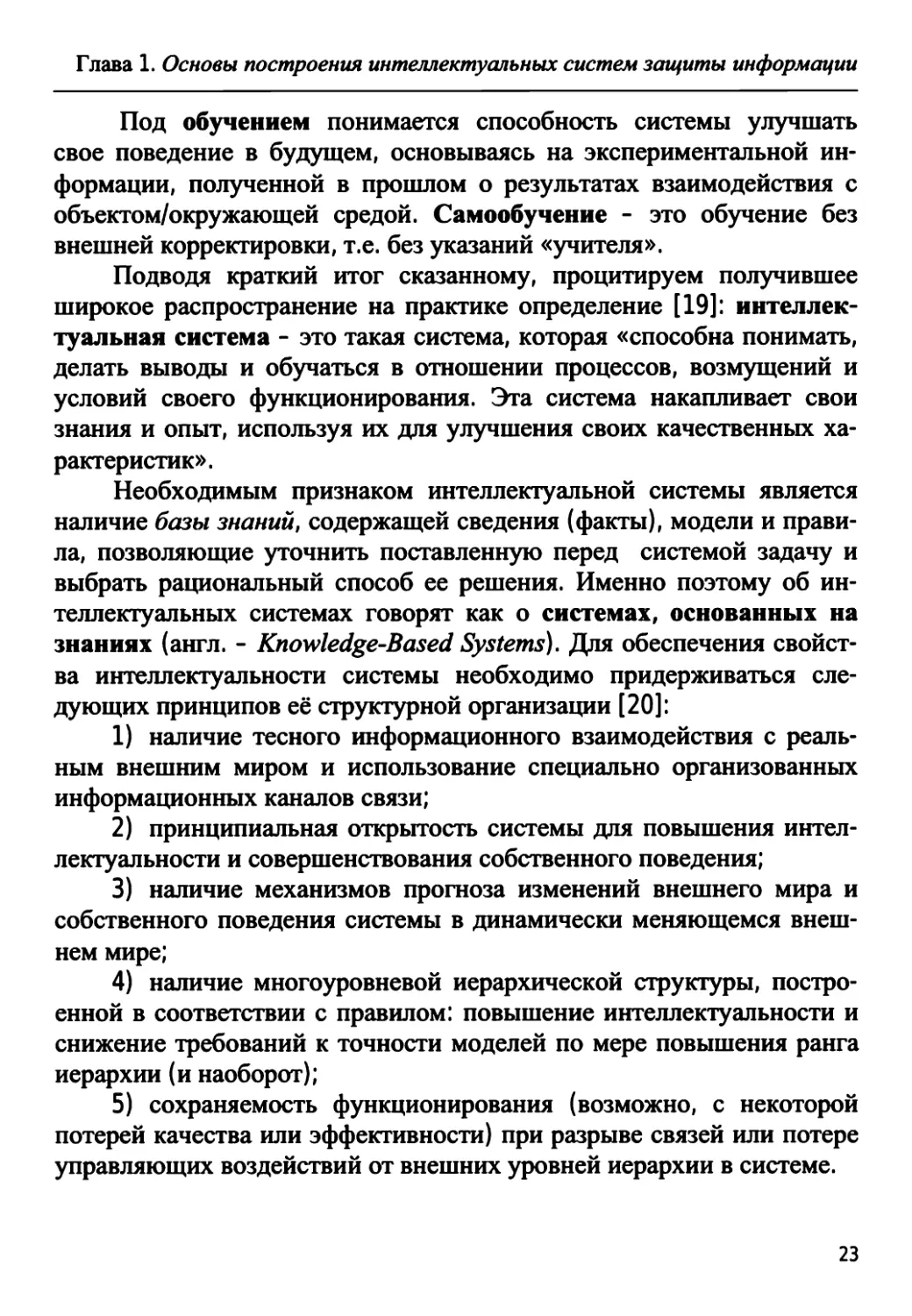

Под обучением понимается способность системы улучшать

свое поведение в будущем, основываясь на экспериментальной ин-

формации, полученной в прошлом о результатах взаимодействия с

объектом/окружающей средой. Самообучение - это обучение без

внешней корректировки, т.е. без указаний «учителя».

Подводя краткий итог сказанному, процитируем получившее

широкое распространение на практике определение [19]: интеллек-

туальная система - это такая система, которая «способна понимать,

делать выводы и обучаться в отношении процессов, возмущений и

условий своего функционирования. Эта система накапливает свои

знания и опыт, используя их для улучшения своих качественных ха-

рактеристик».

Необходимым признаком интеллектуальной системы является

наличие базы знаний, содержащей сведения (факты), модели и прави-

ла, позволяющие уточнить поставленную перед системой задачу и

выбрать рациональный способ ее решения. Именно поэтому об ин-

теллектуальных системах говорят как о системах, основанных на

знаниях (англ. - Knowledge-Based Systems). Для обеспечения свойст-

ва интеллектуальности системы необходимо придерживаться сле-

дующих принципов её структурной организации [20]:

1) наличие тесного информационного взаимодействия с реаль-

ным внешним миром и использование специально организованных

информационных каналов связи;

2) принципиальная открытость системы для повышения интел-

лектуальности и совершенствования собственного поведения;

3) наличие механизмов прогноза изменений внешнего мира и

собственного поведения системы в динамически меняющемся внеш-

нем мире;

4) наличие многоуровневой иерархической структуры, постро-

енной в соответствии с правилом: повышение интеллектуальности и

снижение требований к точности моделей по мере повышения ранга

иерархии (и наоборот);

5) сохраняемость функционирования (возможно, с некоторой

потерей качества или эффективности) при разрыве связей или потере

управляющих воздействий от внешних уровней иерархии в системе.

23

Глава 1. Основы построения интеллектуальных систем защиты информации

Системы, организованные и функционирующие в соответствии

со всеми пятью перечисленными принципами, называются система-

ми, интеллектуальными «в большом».

Как видно из этого определения, система, интеллектуальная «в

большом», должна иметь многоуровневую иерархическую структу-

ру. Наиболее полно указанным выше требованиям удовлетворяет

трехуровневая система управления, включающая в себя:

• исполнительный уровень;

• уровень координации (тактический уровень);

• уровень планирования (стратегический уровень).

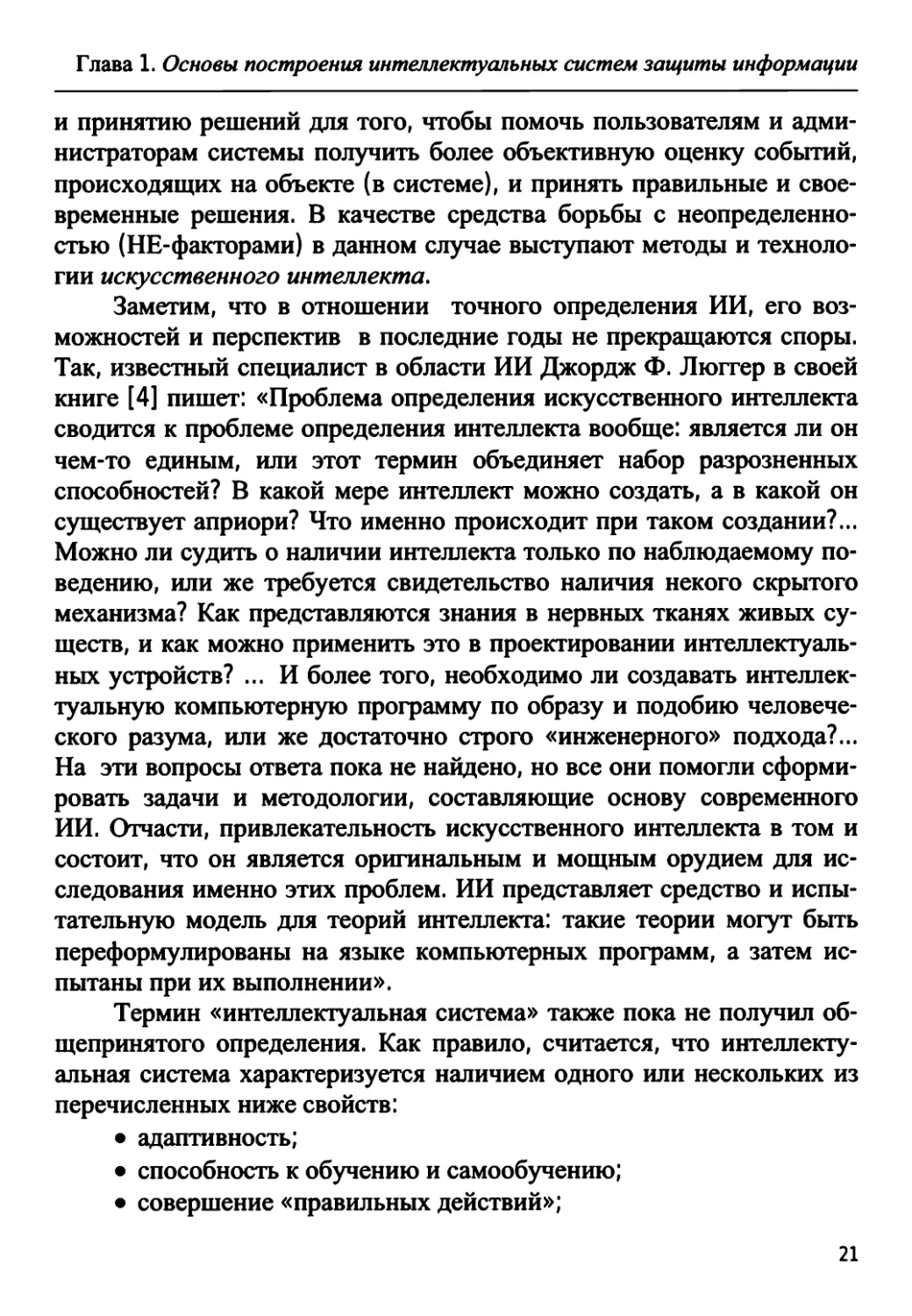

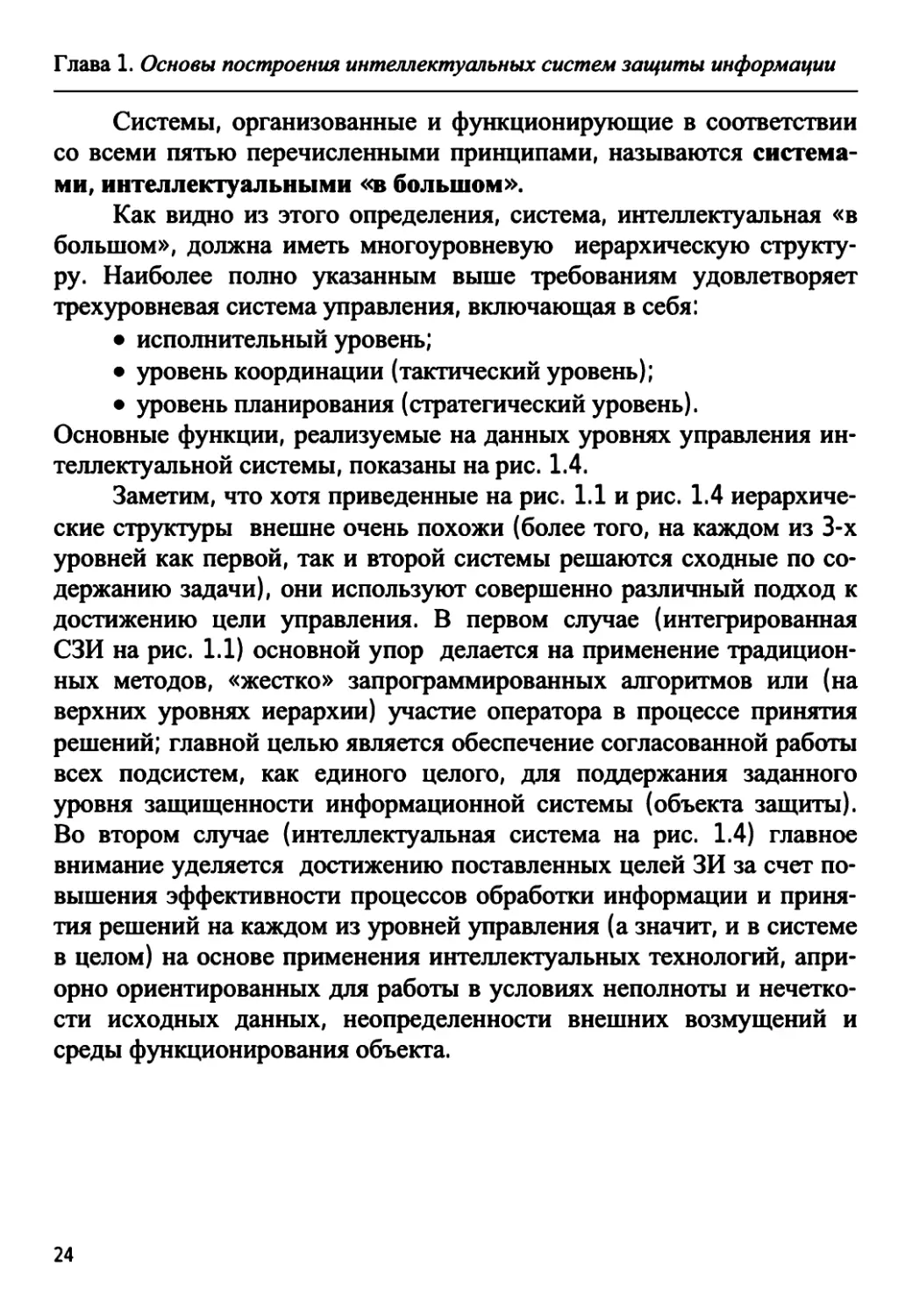

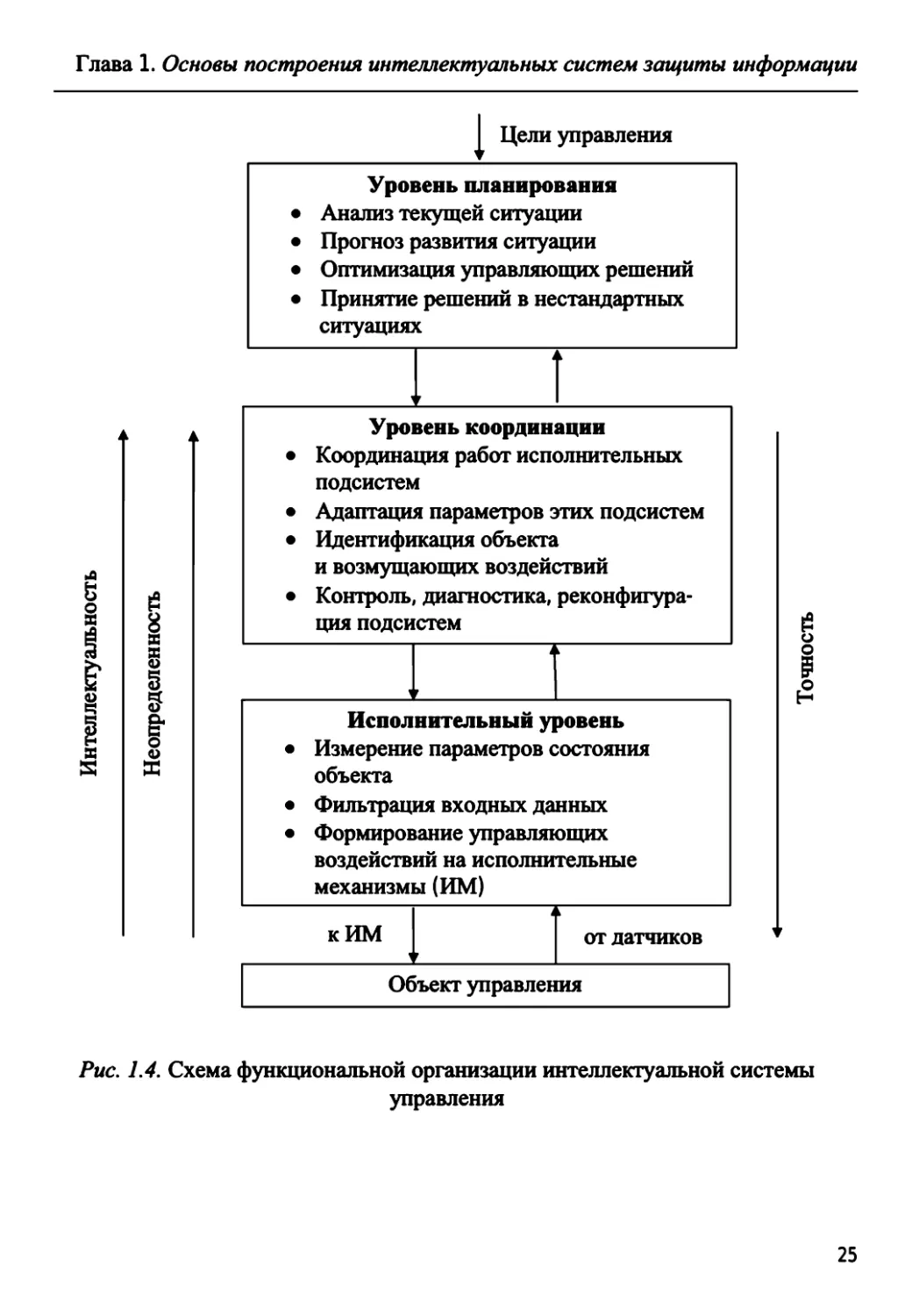

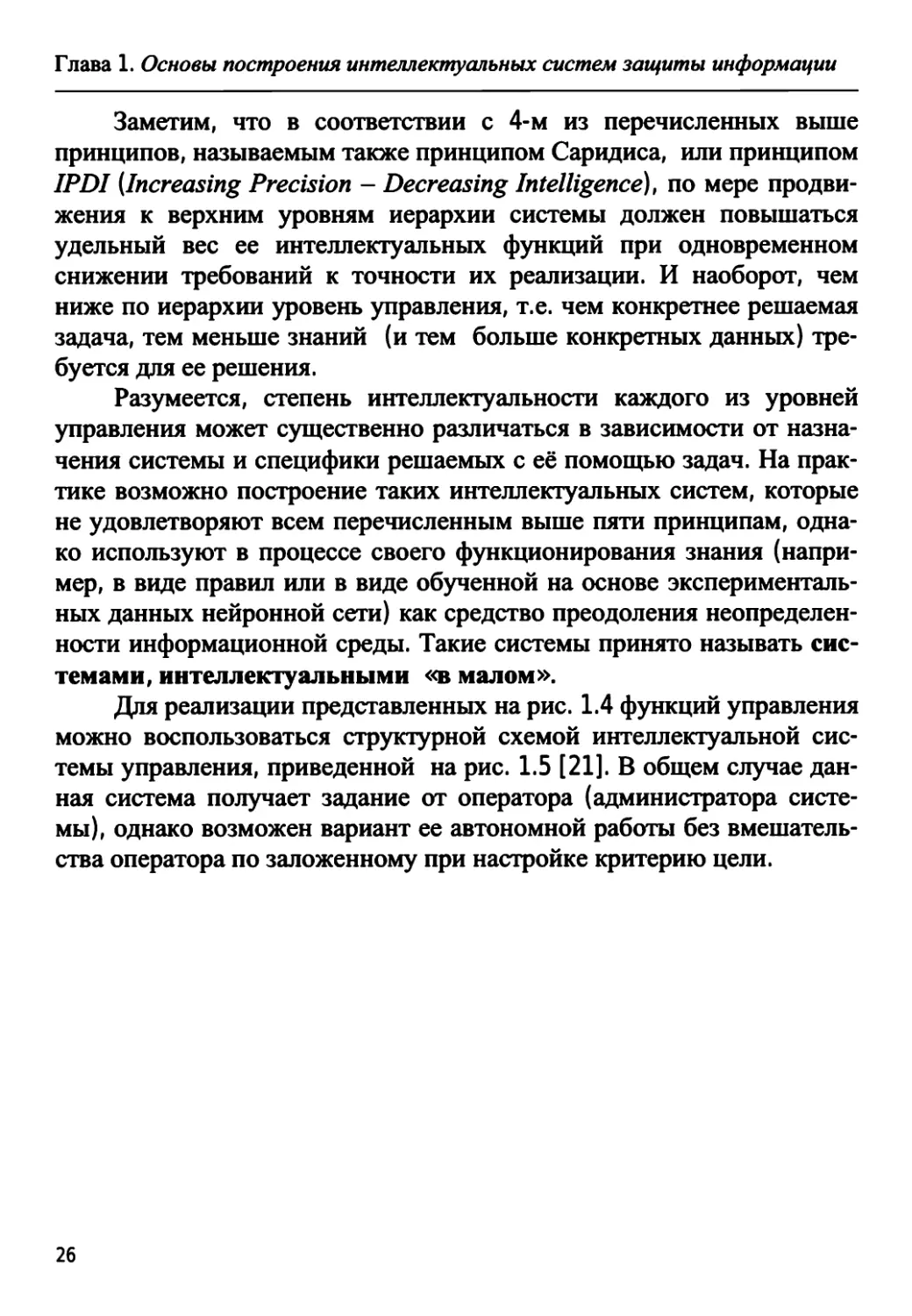

Основные функции, реализуемые на данных уровнях управления ин-

теллектуальной системы, показаны на рис. 1.4.

Заметим, что хотя приведенные на рис. 1.1 и рис. 1.4 иерархиче-

ские структуры внешне очень похожи (более того, на каждом из 3-х

уровней как первой, так и второй системы решаются сходные по со-

держанию задачи), они используют совершенно различный подход к

достижению цели управления. В первом случае (интегрированная

СЗИ на рис. 1.1) основной упор делается на применение традицион-

ных методов, «жестко» запрограммированных алгоритмов или (на

верхних уровнях иерархии) участие оператора в процессе принятия

решений; главной целью является обеспечение согласованной работы

всех подсистем, как единого целого, для поддержания заданного

уровня защищенности информационной системы (объекта защиты).

Во втором случае (интеллектуальная система на рис. 1.4) главное

внимание уделяется достижению поставленных целей ЗИ за счет по-

вышения эффективности процессов обработки информации и приня-

тия решений на каждом из уровней управления (а значит, и в системе

в целом) на основе применения интеллектуальных технологий, апри-

орно ориентированных для работы в условиях неполноты и нечетко-

сти исходных данных, неопределенности внешних возмущений и

среды функционирования объекта.

24

Глава 1. Основы построения интеллектуальных систем защиты информации

Цели управления

8

8

S

S

I

8

§

о

Уровень планирования

Анализ текущей ситуации

Прогноз развития ситуации

Оптимизация управляющих решений

Принятие решений в нестандартных

ситуациях

Уровень координации

Координация работ исполнительных

подсистем

Адаптация параметров этих подсистем

Идентификация объекта

и возмущающих воздействий

Контроль, диагностика, реконфигура-

ция подсистем

Исполнительный уровень

Измерение параметров состояния

объекта

Фильтрация входных данных

Формирование управляющих

воздействий на исполнительные

механизмы (ИМ)

к ИМ

от датчиков

I

е2

Объект управления

Рис. 1.4. Схема функциональной организации интеллектуальной системы

управления

25

Глава 1. Основы построения интеллектуальных систем защиты информации

Заметим, что в соответствии с 4-м из перечисленных выше

принципов, называемым также принципом Саридиса, или принципом

IPDI [Increasing Precision - Decreasing Intelligence), по мере продви-

жения к верхним уровням иерархии системы должен повышаться

удельный вес ее интеллектуальных функций при одновременном

снижении требований к точности их реализации. И наоборот, чем

ниже по иерархии уровень управления, т.е. чем конкретнее решаемая

задача, тем меньше знаний (и тем больше конкретных данных) тре-

буется для ее решения.

Разумеется, степень интеллектуальности каждого из уровней

управления может существенно различаться в зависимости от назна-

чения системы и специфики решаемых с её помощью задач. На прак-

тике возможно построение таких интеллектуальных систем, которые

не удовлетворяют всем перечисленным выше пяти принципам, одна-

ко используют в процессе своего функционирования знания (напри-

мер, в виде правил или в виде обученной на основе эксперименталь-

ных данных нейронной сети) как средство преодоления неопределен-

ности информационной среды. Такие системы принято называть сис-

темами, интеллектуальными «в малом».

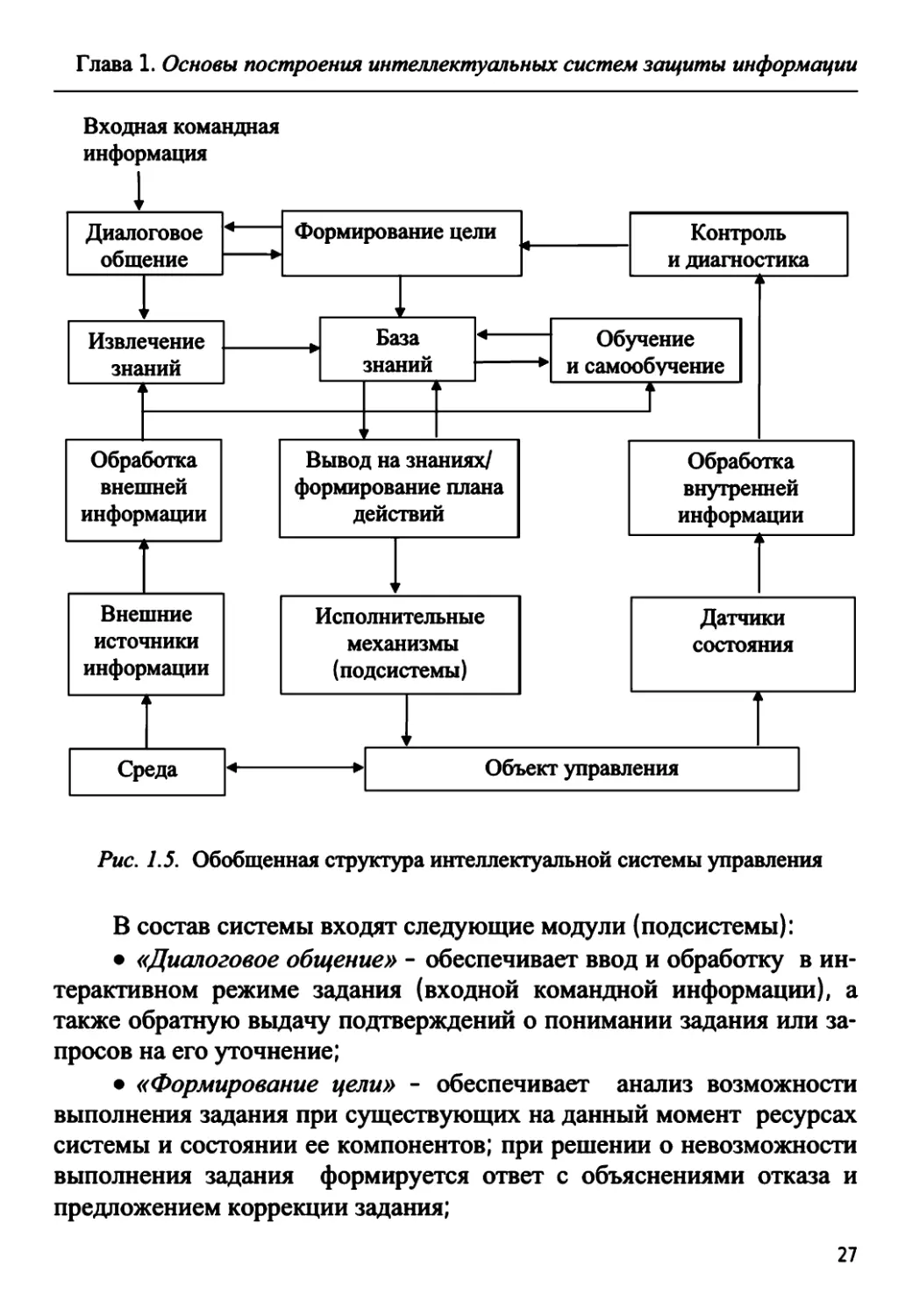

Для реализации представленных на рис. 1.4 функций управления

можно воспользоваться структурной схемой интеллектуальной сис-

темы управления, приведенной на рис. 1.5 [21]. В общем случае дан-

ная система получает задание от оператора (администратора систе-

мы), однако возможен вариант ее автономной работы без вмешатель-

ства оператора по заложенному при настройке критерию цели.

26

Глава 1. Основы построения интеллектуальных систем защиты информации

Входная командная

информация

1

Диалоговое

| общение

1

г

Извлечение

знаний

i

к

Обработка

внешней

информации

1 3

\ '

Внешние

источники

информации

i

к

1 г*

Ср

еда

Формирование цели

▼

База

знаний

\

А

г

^

Вывод на знаниях/

формирование плана

действий

v

Исполнительные

механизмы

(подсистемы)

L

у

Контроль I

и диагностика |

Обучение

и самообучение

t

А

Обработка

внутренней

информации

Датчики

состояния

А

\JKJl

>см уиуавл

СПИЛ

Рис. 1.5. Обобщенная структура интеллектуальной системы управления

В состав системы входят следующие модули (подсистемы):

• «Диалоговое общение» - обеспечивает ввод и обработку в ин-

терактивном режиме задания (входной командной информации), а

также обратную выдачу подтверждений о понимании задания или за-

просов на его уточнение;

• «Формирование цели» - обеспечивает анализ возможности

выполнения задания при существующих на данный момент ресурсах

системы и состоянии ее компонентов; при решении о невозможности

выполнения задания формируется ответ с объяснениями отказа и

предложением коррекции задания;

27

Глава 1. Основы построения интеллектуальных систем защиты информации

• «База знаний» (БЗ) - содержит формализованное в рамках

выбранного метода и языка представления знаний описание объекта,

его среды и правила, необходимые для выполнения поставленного

задания;

• «Извлечение знаний» - обеспечивает формирование знаний о

внешней среде путем интеграции полученной внешней информации и

корректирующей (уточняющей) информации от оператора;

• «Обучение и самообучение» - обеспечивает накопление до-

полнительных знаний о проблеме в режиме «с учителем» и «без учи-

теля» (т.е. автономно);

• «Вывод на знаниях/формирование плана действий» - осущест-

вляет обработку цели и знаний о среде и проблеме для прогнозиро-

вания и формирования управляющих воздействий, подаваемых на

исполнительные механизмы (подсистемы) объекта;

• «Обработка внешней и внутренней информации» - произво-

дит оценку изменения текущего состояния среды и объекта управле-

ния на основании информации, полученной от различных устройств

(сенсоров), связывающих систему с внешней средой (внешние источ-

ники информации), и от датчиков состояния объекта и системы;

• «Контроль и диагностика» - обрабатывает полученную внут-

реннюю информацию об изменениях состояния объекта и системы с

целью выработки контрольной информации, позволяющей анализи-

ровать возможность выполнения задания, поставленного перед сис-

темой.

В основе функционирования интеллектуальной системы

(см. рис. 1.5) используется идея ситуационного управления [22],

суть которого заключается в выборе управленческих решений с уче-

том сложившейся ситуации из некоторого набора допустимых (типо-

вых, стандартных) управляющих воздействий. Под текущей ситуа-

цией (С) при этом понимается совокупность текущего состояния

объекта (вектор состояния X) и его внешней среды (вектор возмуще-

ний F):

C=<X,F>. (1.1)

28

Глава 1. Основы построения интеллектуальных систем защиты информации

Полная ситуация (S) включает в себя, помимо текущей ситуации С,

также цель управления G:

S=<C,G>. (1.2)

В частном случае, цель управления G может быть представлена в ви-

де некоторой целевой ситуации Cg, к которой должна быть приведе-

на имеющаяся текущая ситуация:

S=<C,Gg>. (1.3)

Полагая, что текущая ситуация С принадлежит некоторому

классу Q\ а целевая (заданная) ситуация Cg - классу Q\ будем ис-

кать такое управление (вектор управляющих воздействий U), которое

принадлежит множеству допустимых управлений С1и и обеспечивает

требуемое преобразование одного класса ситуаций в другой:

CeQ Uen" )Gg€g". (1-4)

Таким образом, ситуационное управление выступает как ото-

бражение

(e',e")->Uentt, (1.5)

сопоставляющее паре «текущая ситуация - целевая ситуация» тре-

буемый результат - управление U. Другими словами, проблема вы-

бора управляющих воздействий сводится к адекватной оценке со-

стояния объекта и среды (что не всегда легко сделать в условиях фак-

торов неопределенности), отнесению соответствующей текущей си-

туации к одному из типовых классов и выбору такого управления (из

определенного набора альтернатив), которое приводит к достиже-

нию поставленной цели управления (целевой ситуации).

Очевидно, что перечисленные выше положения, касающиеся

общих принципов построения интеллектуальных систем, имеют уни-

версальный характер и в полной мере относятся к таким сложным

29

Глава 1. Основы построения интеллектуальных систем защиты информации

объектам управления, какими являются объекты защиты информа-

ции. Вместе с тем, на пути создания интеллектуальных систем защи-

ты информации пока имеется много нерешенных проблем, характер-

ных для данной предметной области (существует даже официально

утвержденный INFOSEC список «трудных проблем» в области ИБ

[23]).

Как отмечается в [24] (учитывая важность высказанных сообра-

жений, процитируем их практически полностью), «... основные не-

достатки традиционных СЗИ определяются сложившимися жестки-

ми принципами построения архитектуры и заключаются в практиче-

ской неспособности противодействовать современному информаци-

онному оружию. В современных СЗИ в основном применяются обо-

ронительные или наступательные стратегии защиты, которые пред-

назначены только для блокировки всех известных и наиболее опас-

ных потенциальных способов специальных программно-технических

воздействий (СПТВ), осуществляемых противником ... для нанесения

ущерба информационным ресурсам автоматизированной системы

(АС). Эти стратегии являются изначально проигрышными, так как не

позволяют СЗИ АС успешно противодействовать всем потенциаль-

ным способам СПТВ, следовательно, для решения этой проблемы не-

обходимо использовать в СЗИ АС исключительно упреждающую

стратегию защиты, в основе которой должна быть способность пол-

ной адаптации к любым изменениям условий функционирования АС,

вызванным применением противником информационного оружия.

Постоянная разработка новых методов и средств СПТВ и на-

блюдаемая в последнее время тенденция к постоянному росту коли-

чества случаев успешной реализации СПТВ требуют принципиально

новых подходов к обеспечению безопасности в АС.

Этим обусловлена актуальность создания теории интеллекту-

ального обеспечения безопасности информации АС. В рамках созда-

ния данной теории необходимо комплексное решение ряда функцио-

нальных научных проблем, направленных на исследование и разра-

ботку новых теоретических моделей и методов для создания на их

основе нового поколения интеллектуальных отечественных СЗИ:

Термин «автоматизированная система» используется здесь и ниже как синоним термина

«информационная система».

30

Глава 1. Основы построения интеллектуальных систем защиты информации

• разработка аксиоматической модели угроз безопасности ин-

формации;

• создание математической теории идентификации СПТВ на

АС;

• создание новых математических моделей систем разграниче-

ния доступа, соответствующих информационным процессам в АС;

• создание методологии построения адаптивных СЗИ АС;

• создание методологии построения систем поддержки приня-

тия решений при обеспечении ЗИ в АС;

• разработка замкнутой системы метрологических критериев

оценивания защищенности информации АС;

• создание общей теории информационных рисков;

• создание методологии обеспечения собственной безопасности

СЗИ АС.

Решение указанных фундаментальных научных проблем по-

зволит создавать новые интеллектуальные СЗИ, основным преиму-

ществом которых будет способность предотвращения, обнаружения и

нейтрализации, использования методов и средств СПТВ, имеющих

априорную параметрическую и сигнальную неопределенность.

Основные требования, которым должна удовлетворять пер-

спективная интеллектуальная СЗИ:

• способность обнаруживать априорно неизвестные СПТВ;

• автоматизированная поддержка принятия решений о проти-

водействии СПТВ;

• способность автоматического оценивания изменения уровня

защищенности АС от СПТВ при изменении условий функциониро-

вания;

• автоматизированная поддержка принятия решений о перерас-

пределении ресурсов СЗИ АС;

• автоматическое изменение своих свойств и параметров в за-

висимости от изменения условий среды функционирования, на осно-

ве накопления и использования информации о ней;

• способность к дезинформации нападающей стороны об ис-

тинных свойствах и параметрах АС;

• способность к снижению нецелевой нагрузки на комплекс

средств автоматизации АС;

31

Глава 1. Основы построения интеллектуальных систем защиты информации

• автоматическое воздействие на ресурсы нападающей стороны

(время, вычислительные и коммуникационные ресурсы).

Исходя из вышеизложенного, архитектура перспективной ин-

теллектуальной СЗИ АС должна включать в себя следующие функ-

циональные компоненты:

• подсистему обнаружения СПТВ;

• подсистему накопления данных;

• подсистему анализа защищенности;

• подсистему адаптации СЗИ;

• подсистему активного противодействия СПТВ»3.

Данной тематике в последнее время уделяется большое внима-

ние в специальной литературе. Так, вопросам интеллектуального

противодействия информационному нападению в корпоративных

информационно-вычислительных сетях посвящена монография [25],

в которой предлагается использовать для этих целей аппарат обучае-

мых М-сетей, генетические алгоритмы оптимизации, концепцию «ис-

кусственной жизни». Общая концепция построения модели адаптив-

ной системы защиты информации, реализуемой на основе биосис-

темной аналогии с использованием интеллектуальных механизмов

нейронных сетей и нечеткой логики, рассмотрена в учебном пособии

[26]. Конструктивные подходы, связанные с построением моделей

комплексной оценки угроз безопасности информации, анализом ин-

формационных рисков, построением систем обнаружения атак и сис-

тем поддержки принятия решений по управлению ЗИ с использова-

нием методов искусственного интеллекта, рассматриваются в работах

[27 - 36] и др. Разработке методов и алгоритмов управления защитой

информации в корпоративных информационных системах с исполь-

зованием интеллектуальных технологий посвящена докторская дис-

сертация И. В. Машкиной [37].

Вместе с тем, в силу широты и многоплановости проблемы соз-

дания интеллектуальных СЗИ, ограничимся ниже рассмотрением

лишь отдельных частных аспектов (задач) в рамках решения этой

проблемы, связанных с построением ряда ключевых функциональных

подсистем СЗИ с применением методов искусственного интеллекта.

3 Конец цитаты.

32

Глава 1. Основы построения интеллектуальных систем защиты информации

Контрольные вопросы

1. Сформулируйте основные системные принципы защиты ин-

формации.

2. Перечислите основные уровни обеспечения информационной

безопасности. Какие задачи решаются на этих уровнях?

3. Какие базовые подсистемы входят в состав интегрированной

системы защиты информации?

4. Что понимается под интеллектуализацией систем защиты

информации? Перечислите основные принципы структурной органи-

зации интеллектуальной системы.

5. Каковы основные направления развития интеллектуальных

систем защиты информации?

33

Глава 2. Биометрические системы идентификации личности

ГЛАВА 2. БИОМЕТРИЧЕСКИЕ СИСТЕМЫ

ИДЕНТИФИКАЦИИ ЛИЧНОСТИ

2.L Биометрические технологии: классификация,

сравнительные характеристики

Под биометрией (англ. - Biometrics), применительно к сфере

информационной безопасности, понимается область знаний, пред-

ставляющая методы автоматической идентификации и подтвержде-

ния личности человека по его физиологическим и поведенческим ха-

рактеристикам. Сегодня этой теме посвящено большое количество

публикаций (см., например, [38 - 43]). Подробная информация для

специалистов и непрофессионалов выставлена на Российском био-

метрическом портале http://www.biometrics.org.

С помощью биометрических методов (средств) предприятия пы-

таются сегодня защитить данные, здания, системы. Рынок распозна-

вания особенностей человеческого тела переживает настоящий бум

(говорят даже о «биометрической революции»). По данным исследо-

вания ведущей в данной области консалтинговой компании Interna-

tional Biometrics Group, в 2009 г. мировой оборот биометрических

средств достиг уже 3,4 млрд дол. К 2014 г., как утверждают аналити-

ки, эта цифра должна возрасти до 9,4 млрд дол., что соответствует

годовому росту в 30 %.

Ещё в 90-х гг. прошлого столетия биометрические системы ис-

пользовались главным образом для защиты военных секретов и особо

важной коммерческой информации. В наши дни биометрическими

системами доступа оборудовали аэропорты, крупные торговые цен-

тры, офисы многих компаний. Повышенный спрос стимулировал ис-

следования в этой области, что, в свою очередь, привело к появлению

новых устройств и новых технологий. На рынке биометрических

продуктов, наряду с устоявшимися лидерами - Identix, Digital

Persona, Precise Biometrics, Visionics, Ethentica, BioScript, Secugen, Ac-

Sys Biometrics, появились мощные корпорации, не специализировав-

шиеся ранее в области биометрии - Sony, Panasonic, LG, Compaq и

др.

34

Глава 2. Биометрические системы идентификации личности

Обычно при классификации биометрических технологий выде-

ляют две группы биометрических систем по типу используемых био-

метрических признаков.

Первая группа систем использует статические биометрические

признаки, полученные человеком с рождения и практически не изме-

няющиеся во времени. К таким признакам относятся:

• отпечатки пальцев;

• радужная оболочка глаза;

• изображение лица;

• геометрия кисти руки;

• рисунок пальцев руки;

• ДНК и др.

Вторая группа систем использует для идентификации динамиче-

ские биометрические признаки, подверженные изменениям во време-

ни и отражающие такие индивидуальные особенности каждого чело-

века, как:

• рукописный почерк (подпись);

• голос;

• манера работать на клавиатуре и др.

Каждый из этих признаков имеет свои достоинства и недостат-

ки. Преимуществом использования статических биометрических при-

знаков является их относительная независимость от психофизическо-

го состояния личности, малые затраты на реализацию алгоритмов

распознавания и, как следствие, возможность организации биометри-

ческой идентификации больших потоков людей. Не случайно, наи-

большее распространение на практике получили биометрические ме-

тоды, относящиеся именно к этой (первой) группе и основанные на

использовании первых 3-х из упомянутых выше признаков (распо-

знавание по отпечаткам пальцев, радужной оболочке глаза и особен-

ностям геометрии лица). Недостатком статической биометрии явля-

ется статичность (фиксированность) используемых биометрических

признаков, вследствие чего появляется соблазн их подделки (подме-

ны), требование наличия специального считывающего оборудования.

В отличие от методов первой группы, методы динамической

биометрии обеспечивают большую вариантность (так, подпись или

парольную фразу всегда легко сменить); они легко реализуются про-

35

Глава 2. Биометрические системы идентификации личности

граммным путем, с использованием стандартных периферийных уст-

ройств компьютера. Данные обстоятельства делают динамическую

биометрию более предпочтительной для аутентификации / идентифи-

кации личности при удаленном доступе пользователя. Основной не-

достаток динамических методов - влияние на работу биометрической

системы психофизического состояния личности (усталость, испуг,

воздействие лекарственных препаратов).

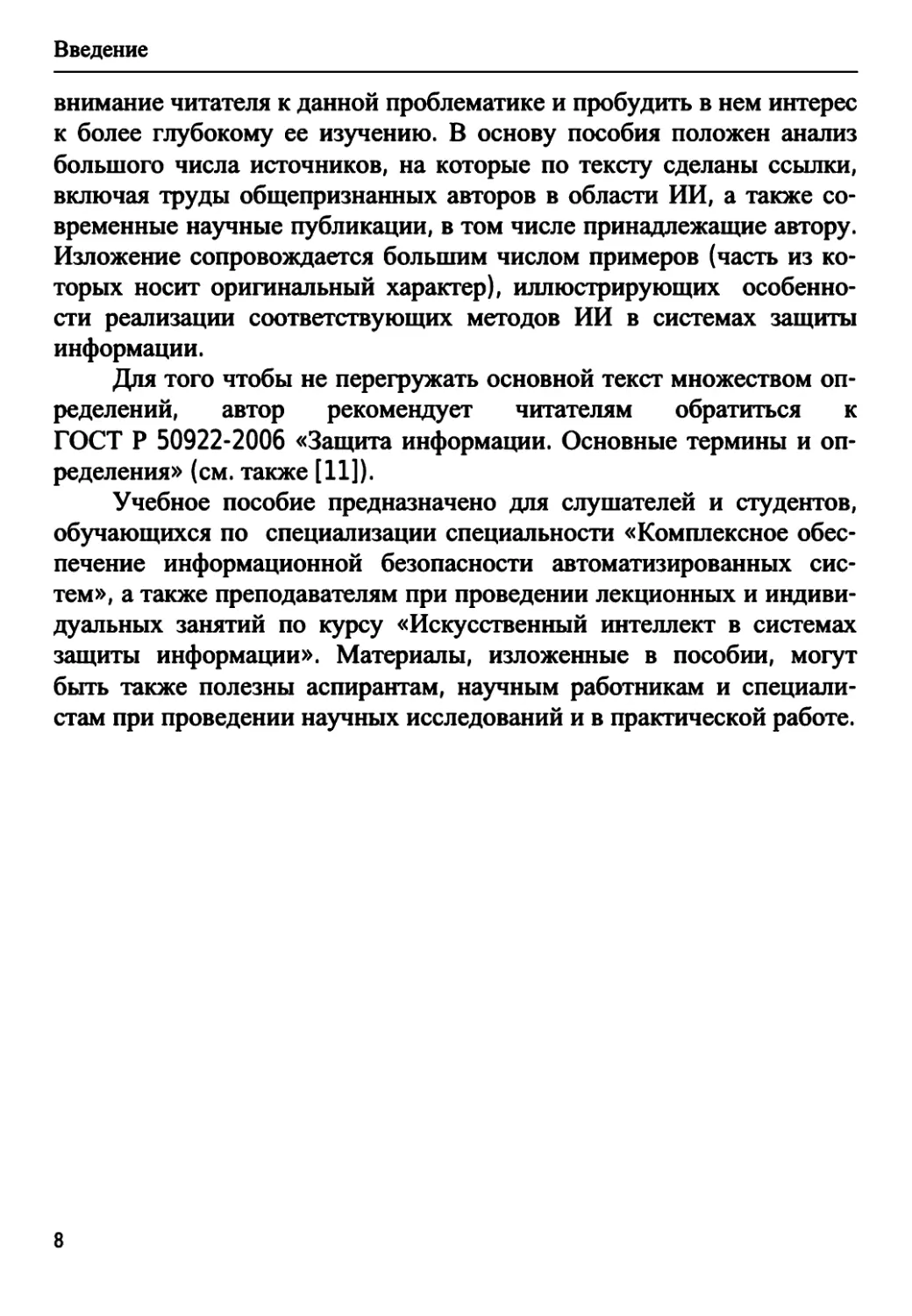

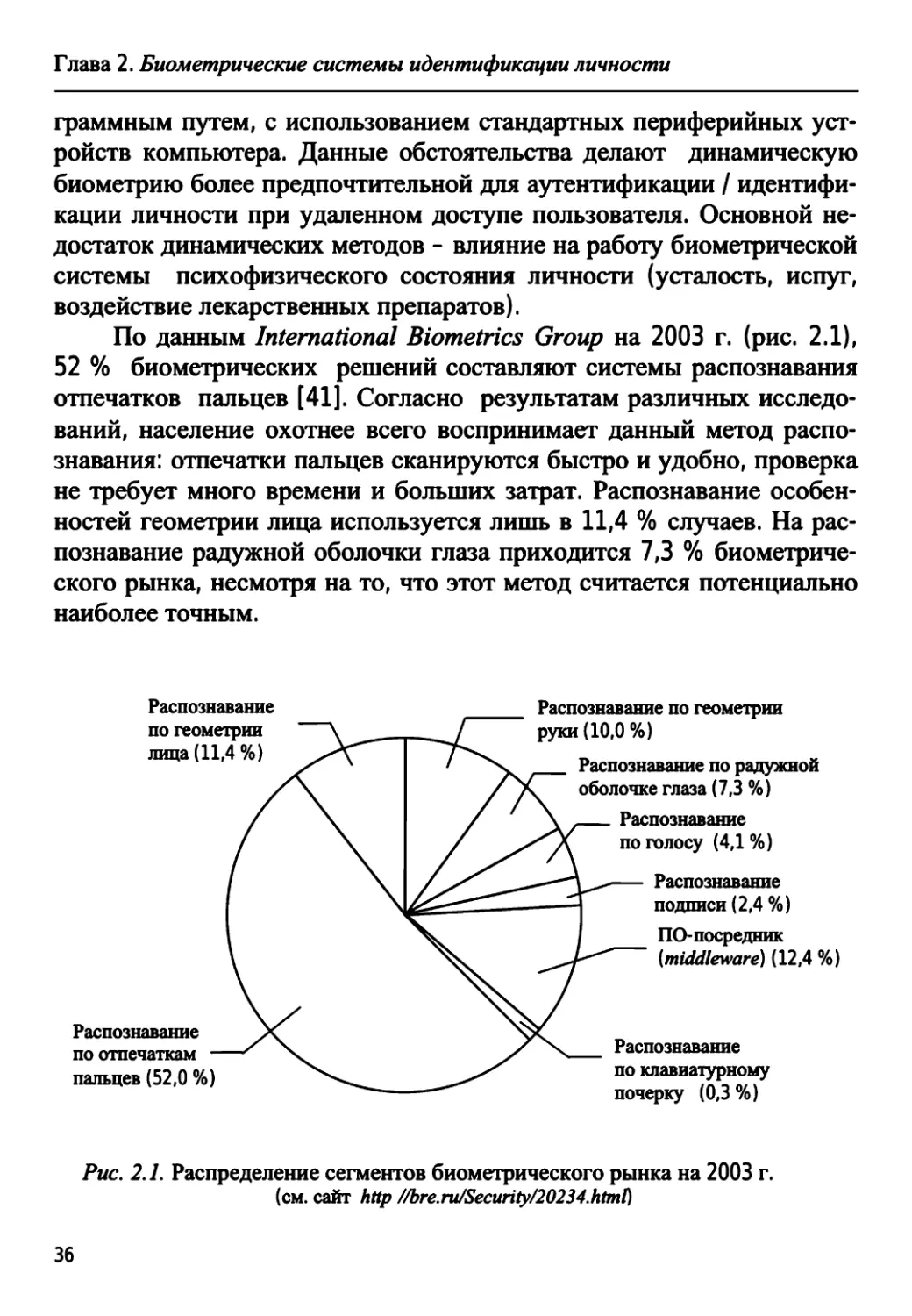

По данным International Biometrics Group на 2003 г. (рис. 2.1),

52 % биометрических решений составляют системы распознавания

отпечатков пальцев [41]. Согласно результатам различных исследо-

ваний, население охотнее всего воспринимает данный метод распо-

знавания: отпечатки пальцев сканируются быстро и удобно, проверка

не требует много времени и больших затрат. Распознавание особен-

ностей геометрии лица используется лишь в 11,4 % случаев. На рас-

познавание радужной оболочки глаза приходится 7,3 % биометриче-

ского рынка, несмотря на то, что этот метод считается потенциально

наиболее точным.

Распознавание

по геометрии

лица (11,4%)

Распознавание

по отпечаткам

пальцев (52,0 %)

Распознавание по геометрии

руки (10,0%)

Распознавание по радужной

оболочке глаза (7,3 %)

Распознавание

по голосу (4,1 %)

Распознавание

подписи (2,4 %)

ПО посредник

(middleware) (12,4 %)

Распознавание

по клавиатурному

почерку (0,3 %)

Рис. 2.1. Распределение сегментов биометрического рынка на 2003 г.

(см. сайт http //bre.ru/Security/20234.html)

36

Глава 2. Биометрические системы идентификации личности

Заметим, что именно цифровое изображение лица сегодня при-

знано обязательным во всех странах для паспортно-визовых докумен-

тов нового поколения (биометрических паспортов) , тогда как два

других параметра - отпечатки пальцев и изображение радужной

оболочки глаза - считаются дополнительными, и каждое государство

может включать их в биометрические паспорта по своему усмотре-

нию. Интересно, что именно по инициативе России была принята по-

правка к международному стандарту в области биометрии

(ISO/IEC 19794-5), суть которой заключается во включении трехмер-

ного цифрового изображения лица, наряду с обычной двухмерной

фотографией, в формат данных, предназначаемый для хранения, об-

мена и использования при автоматическом распознавании личности.

Трехмерная (3D) фотография - новейшая биометрическая техноло-

гия, созданная отечественными разработчиками (фирма А4 Vision).

Трехмерное фото, занимая всего 5 Кбайт, может быть записано в

биометрический паспорт, оно увеличивает точность идентификации

личности и повышает надежность автоматической сверки докумен-

тов. Эксперты отмечают, что уровень распознавания трехмерной фо-

тографии составляет более 90 %, тогда как у двухмерного изображе-

ния этот показатель редко превышает 50 % [42].

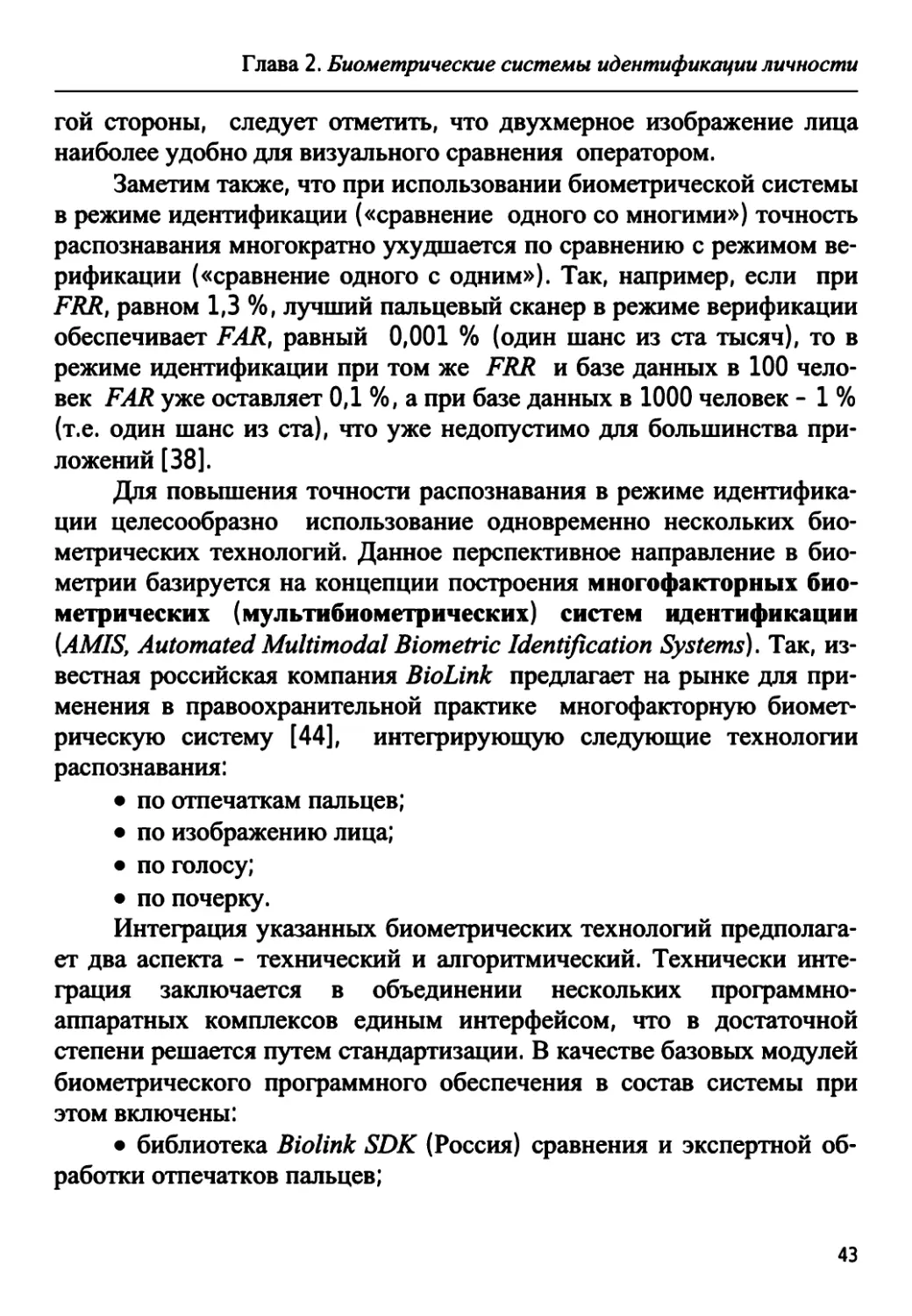

В основе функционирования любой биометрической системы

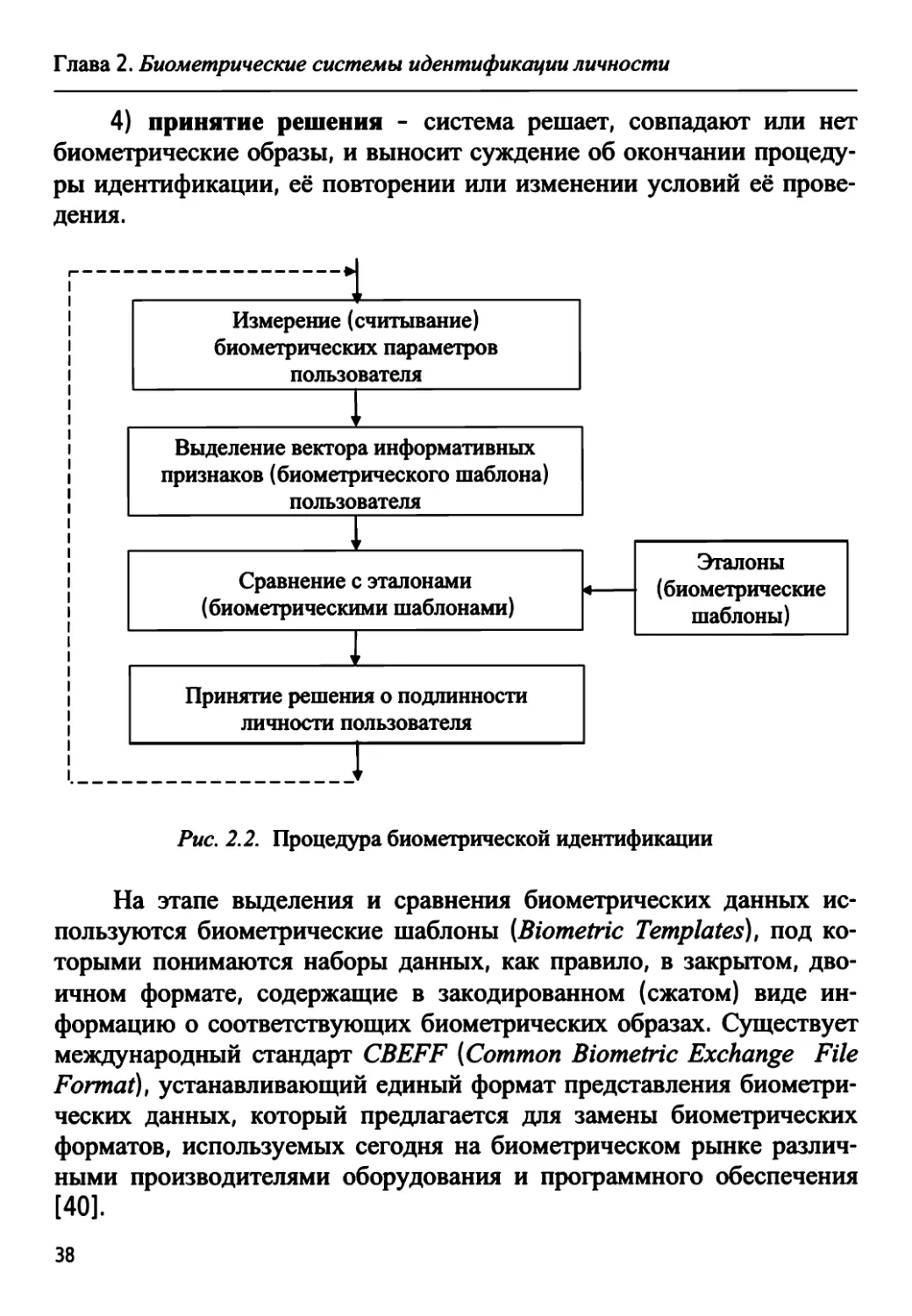

лежит цепочка следующих действий (рис. 2.2):

1) запись - считываются с помощью сканера биометрические

данные пользователя;

2) выделение - из представленных биометрических данных из-

влекается уникальная информация (в виде вектора информативных

признаков или короткого идентификационного кода, длиной до 1000

бит), которая и будет представлять собой биометрический «образ»

конкретного человека;

3) сравнение - производится сравнение представленного био-

метрического образа с одним или большим числом эталонов (шабло-

нов), хранящихся в базе данных системы;

1В России первые биометрические паспорта начали выдаваться с 2006 г.

37

Глава 2. Биометрические системы идентификации личности

4) принятие решения - система решает, совпадают или нет

биометрические образы, и выносит суждение об окончании процеду-

ры идентификации, её повторении или изменении условий её прове-

дения.

1

| Измерение (считывание)

| биометрических параметров

i пользователя

Выделение вектора информативных

признаков (биометрического шаблона)

пользователя

Сравнение с эталонами

(биометрическими шаблонами)

i Принятие решения о подлинности

{ личности пользователя

!_„' "Л

Рис. 2.2. Процедура биометрической идентификации

На этапе выделения и сравнения биометрических данных ис-

пользуются биометрические шаблоны (Biometric Templates), под ко-

торыми понимаются наборы данных, как правило, в закрытом, дво-

ичном формате, содержащие в закодированном (сжатом) виде ин-

формацию о соответствующих биометрических образах. Существует

международный стандарт CBEFF (Common Biometric Exchange File

Format), устанавливающий единый формат представления биометри-

ческих данных, который предлагается для замены биометрических

форматов, используемых сегодня на биометрическом рынке различ-

ными производителями оборудования и программного обеспечения

[40].

4

Эталоны

(биометрические

шаблоны)

38

Глава 2. Биометрические системы идентификации личности

Различают два возможных режима работы биометрической сис-

темы - верификация («сравнение одного с одним») и идентифика-

ция («сравнение одного с многими»).

В режиме верификации пользователь предъявляет системе свои

биометрические данные («биометрику»), объявляя тем самым ей,

«кто он такой». Задача системы в данном случае - проверить «прав-

дивость» полученной информации, т.е. сверить соответствие полу-

ченных биометрических данных с записанным ранее шаблоном (эта-

лоном) заявленного индивидуума.

В режиме идентификации пользователь также предъявляет сис-

теме свою биометрику, однако задача системы меняется - необходи-

мо принять решение, принадлежит ли пользователь к числу извест-

ных ей индивидуумов, и если принадлежит, то - кто он? В этом слу-

чае измеренные биометрические данные сравниваются с базой дан-

ных ранее записанных шаблонов всех «известных» системе людей.

Очевидно, что в реальных условиях применения биометриче-

ские системы сталкиваются с рядом проблем, одна из которых заклю-

чается в необходимости обеспечения высокой надежности распозна-

вания личности. Сложность решения этой проблемы заключается в

том, что:

а) сама процедура биометрической идентификации / верифика-

ции имеет вероятностный характер, поскольку сами измеряемые

биометрические данные подвержены влиянию большого числа фак-

торов неопределенности, а значит, сохраняется определенная вероят-

ность «не признать своего» и «признать своего чужим»;

б) биометрическая система должна быть защищена от созна-

тельного обмана, т.е. возможности подмены объекта биометрическо-

го сканирования;

в) приобретает особую остроту вопрос о сохранности собранной

биометрической информации (речь идет не только о возможности её

взлома и т.д., но и о том, что любой биокод, например, состояние ра-

дужной оболочки глаза или вен руки, несет в себе много информации

о состоянии здоровья конкретного человека и т.д., что может быть

использовано в противоправных целях).

2 Фактически здесь и ниже речь идет об аутентификации пользователя.

39

Глава 2. Биометрические системы идентификации личности

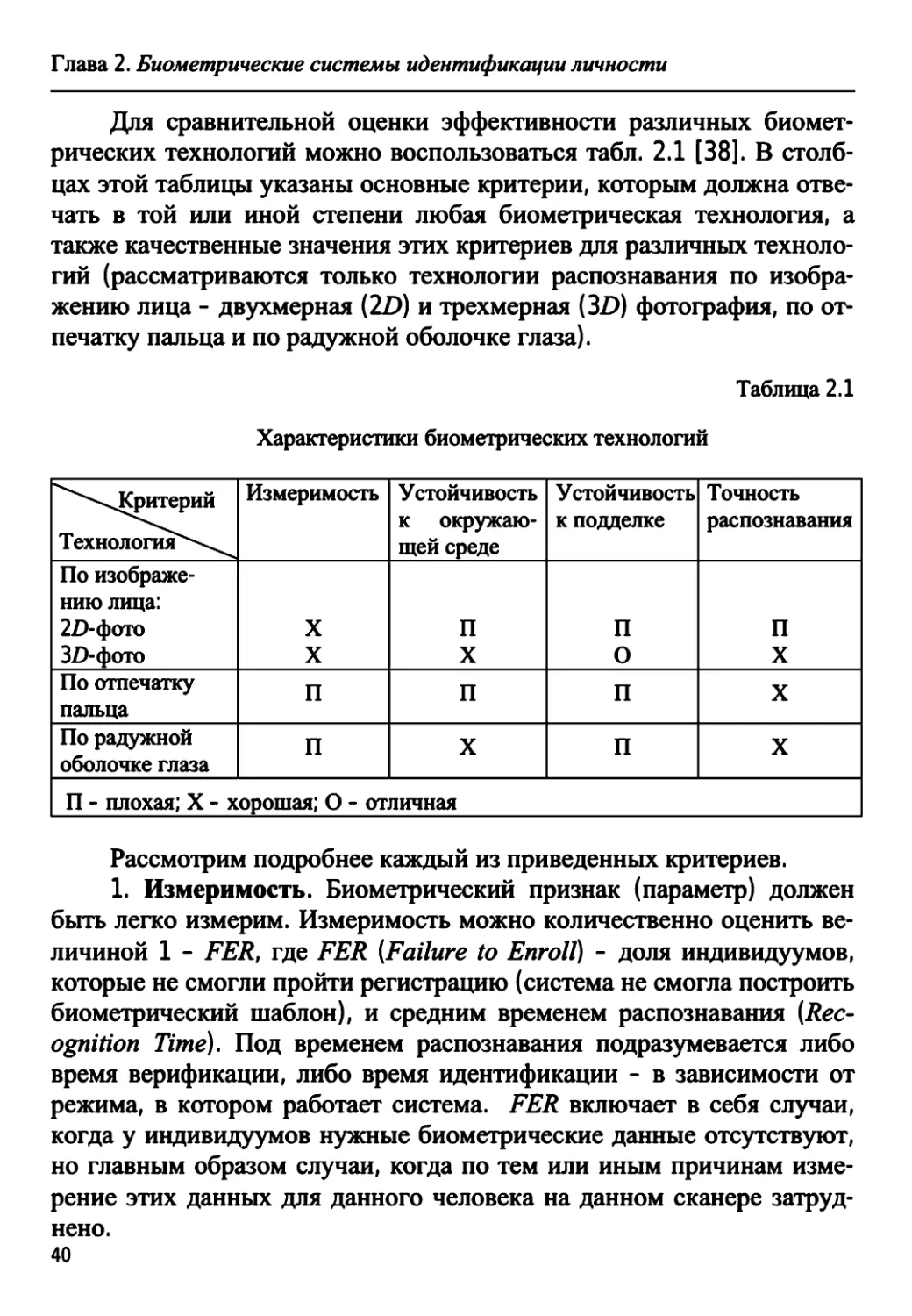

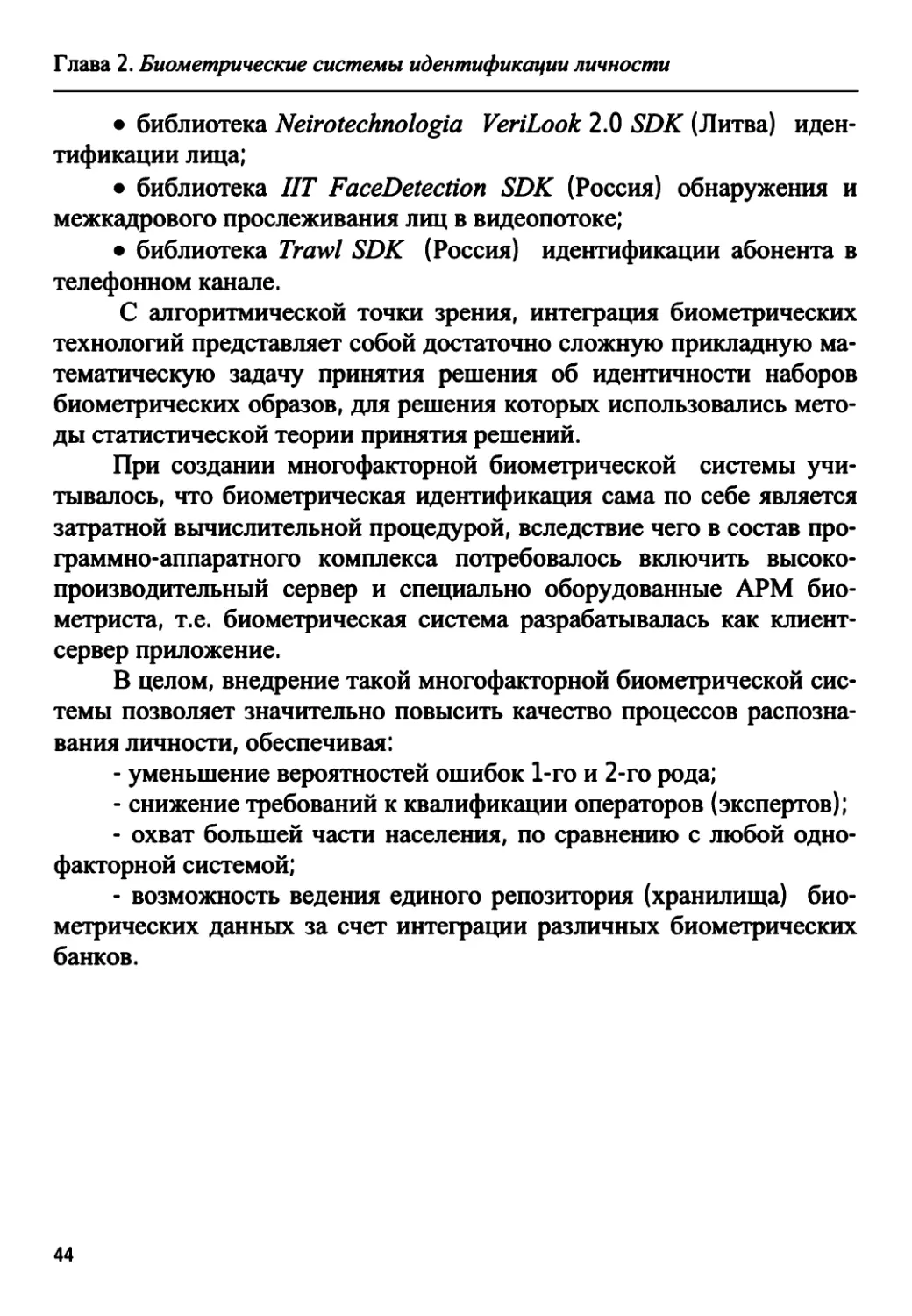

Для сравнительной оценки эффективности различных биомет-

рических технологий можно воспользоваться табл. 2.1 [38]. В столб-

цах этой таблицы указаны основные критерии, которым должна отве-

чать в той или иной степени любая биометрическая технология, а

также качественные значения этих критериев для различных техноло-

гий (рассматриваются только технологии распознавания по изобра-

жению лица - двухмерная (2D) и трехмерная (3D) фотография, по от-

печатку пальца и по радужной оболочке глаза).

Таблица 2.1

Характеристики биометрических технологий

Гч%ч,ч->ххКритерий

Технология4"**--^

По изображе-

нию лица:

2/>фото

3/)-фото

По отпечатку

пальца

По радужной

оболочке глаза

Измеримость

X

X

п

п

Устойчивость

к окружаю-

щей среде

П

X

П

X

Устойчивость

к подделке

П

О

П

П

Точность

распознавания

П

X

X

X

П - плохая; X - хорошая; О - отличная

Рассмотрим подробнее каждый из приведенных критериев.

1. Измеримость. Биометрический признак (параметр) должен

быть легко измерим. Измеримость можно количественно оценить ве-

личиной 1 - FER, где FER (Failure to Enroll) - доля индивидуумов,

которые не смогли пройти регистрацию (система не смогла построить

биометрический шаблон), и средним временем распознавания (Rec-

ognition Time). Под временем распознавания подразумевается либо

время верификации, либо время идентификации - в зависимости от

режима, в котором работает система. FER включает в себя случаи,

когда у индивидуумов нужные биометрические данные отсутствуют,

но главным образом случаи, когда по тем или иным причинам изме-

рение этих данных для данного человека на данном сканере затруд-

нено.

40

Глава 2. Биометрические системы идентификации личности

Так, например, для распознавания по радужной оболочке глаза

требуется ее изображение высокого разрешения, что приводит к оп-

ределенным затруднениям, связанным с необходимостью точного по-

зиционирования глаза по отношению к сканирующему устройству.

Распознавание многих групп людей по отпечаткам пальцев за-

труднено, особенно это касается работников физического труда, лю-

дей со слабо выраженными папиллярными узорами и дефектами ко-

жи, пожилых людей с сухой кожей. Методы распознавания по изо-

бражению лица - бесконтактные и потому обладают высокой изме-

римостью биометрического признака.

2. Устойчивость к окружающей среде. Биометрическая техно-

логия должна быть устойчива к изменению окружающей среды. Экс-

плуатационные качества различных технологий в значительной сте-

пени зависят от окружающих условий и могут терять стабильность

при изменении этих условий. Так, сканеры отпечатков пальцев, как

правило, быстро загрязняются. В этом случае качество работы падает,

а для распознавания лица по двухмерной фотографии большое значе-

ние имеет распределение внешней освещенности.

3. Устойчивость к подделке. Биометрическая система должна

быть устойчивой к различного рода подделкам (несанкционирован-

ному доступу). Систему распознавания по двухмерному изображе-

нию лица легко обмануть, предъявив ей фотографию «правильного»

человека из числа «знакомых» системе. Украсть изображение чужой

оболочки глаза, конечно, сложнее, чем фотографию лица, но если это

сделано, то систему также можно обмануть фотографическим изо-

бражением «нужного» глаза, распечатанным с высоким разрешением

или нанесенным на контактную линзу.

Для получения несанкционированного доступа по отпечатку

пальца, в принципе, можно снять отпечатки пальцев «нужного» ин-

дивидуума, оставленные на любой поверхности, оцифровать их и

обработать полученное изображение на компьютере, после чего изго-

товить «фальшивый» палец либо накладку на него (классический

пример, часто цитируемый в литературе, - японский криптограф Цу-

тому Мацумото с группой своих студентов из университета Иокога-

мы показал, как легко в лабораторных условиях изготовить фальши-

вые отпечатки пальцев, с помощью которых можно обмануть практи-

41

Глава 2. Биометрические системы идентификации личности

чески любую современную систему биометрической аутентифика-

ции).

Наиболее устойчивой к подделке является технология распозна-

вания по трехмерному изображению лица. Для того чтобы обмануть

такую систему, потребовалось бы изготовить точную твердотельную

маску лица, повторяющую во всех деталях его геометрию, что на

практике представляется затруднительным.

4. Точность распознавания. Для оценки точности работы био-

метрической системы обычно используются следующие показатели:

- FAR (False Acceptance Rate) - вероятность ложного распозна-

вания, когда система предоставляет доступ незарегистрированному

пользователю;

- FRR (False Rejection Rate) - вероятность ложного отказа в дос-

тупе, когда система не распознает «знакомого» ей субъекта и соот-

ветственно признает его за «чужого».

В теории статистических решений значения FRR и FAR принято

называть соответственно ошибками 1-го и 2-го рода.

На практике любую биометрическую систему можно настроить

на разную степень «бдительности», т.е. на разное значение вероятно-

сти ложного распознавания FAR. Но уменьшение FAR всегда приво-

дит к уменьшению чувствительности системы и увеличению вероят-

ности ложного отказа (нераспознавания) FRR. Таким образом, чем

«бдительнее» настроена система на непропускание «чужих», тем она

менее чувствительна, а значит, хуже пропускает «своих». В совре-

менных системах значения FAR составляют доли процента, значения

FRR - несколько процентов (2 ... 5 %).

Как показывают исследования, конкретные показатели точности

системы сильно варьируются в зависимости от производителя и ме-

тодики тестирования, однако важно, что три из указанных в табл. 2.1

технологий распознавания - по трехмерному изображению лица, по

отпечатку пальца и по радужной оболочке глаза - обладают сравни-

мой точностью.

При этом распознавание по двухмерному изображению лица

существенно уступает по точности перечисленным технологиям, так

же как и другие, не представленные в табл. 2.1, биометрические тех-

нологии (распознавание по геометрии руки, по голосу и др.). С дру-

42

Глава 2. Биометрические системы идентификации личности

гой стороны, следует отметить, что двухмерное изображение лица

наиболее удобно для визуального сравнения оператором.

Заметим также, что при использовании биометрической системы

в режиме идентификации («сравнение одного со многими») точность

распознавания многократно ухудшается по сравнению с режимом ве-

рификации («сравнение одного с одним»). Так, например, если при

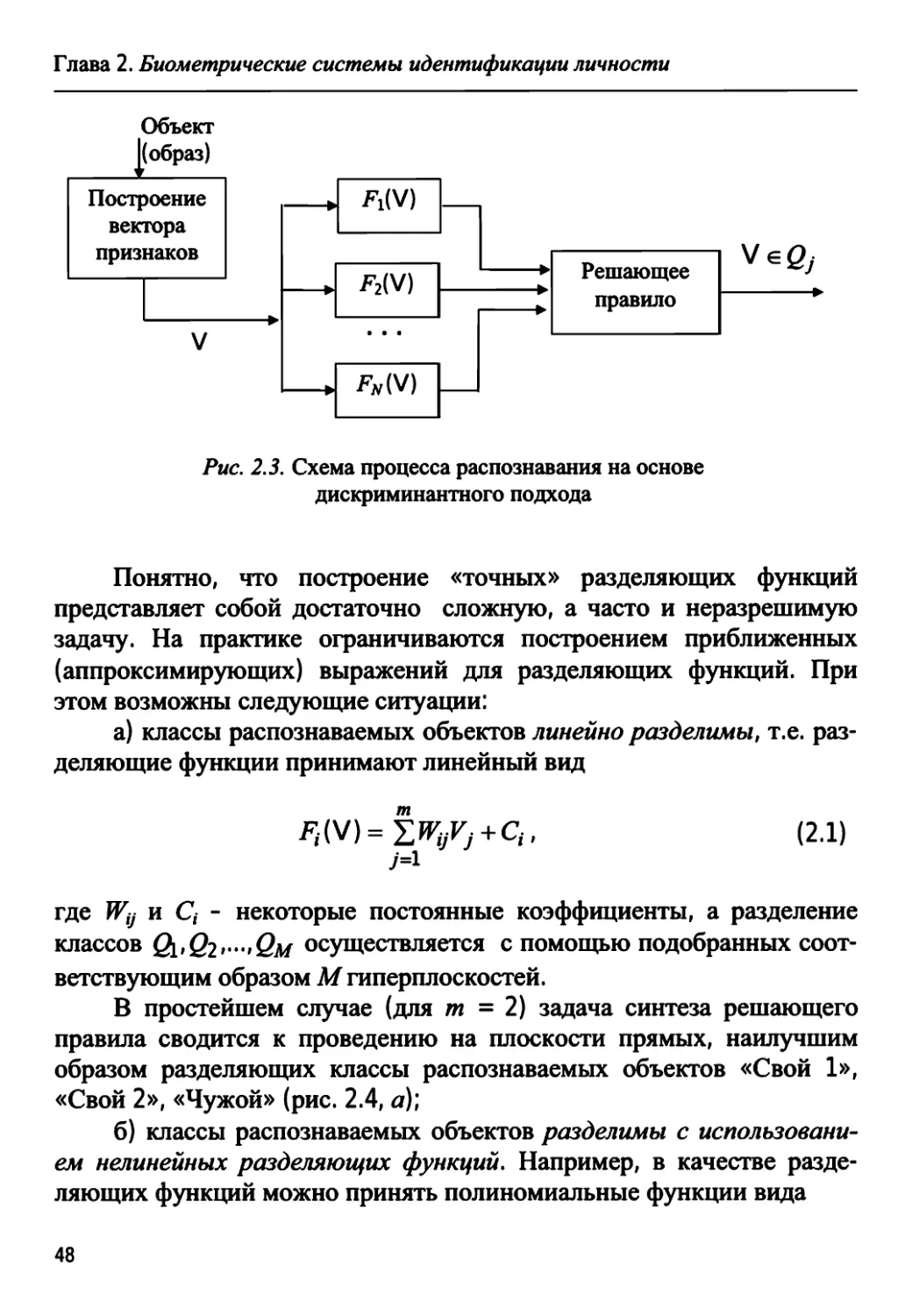

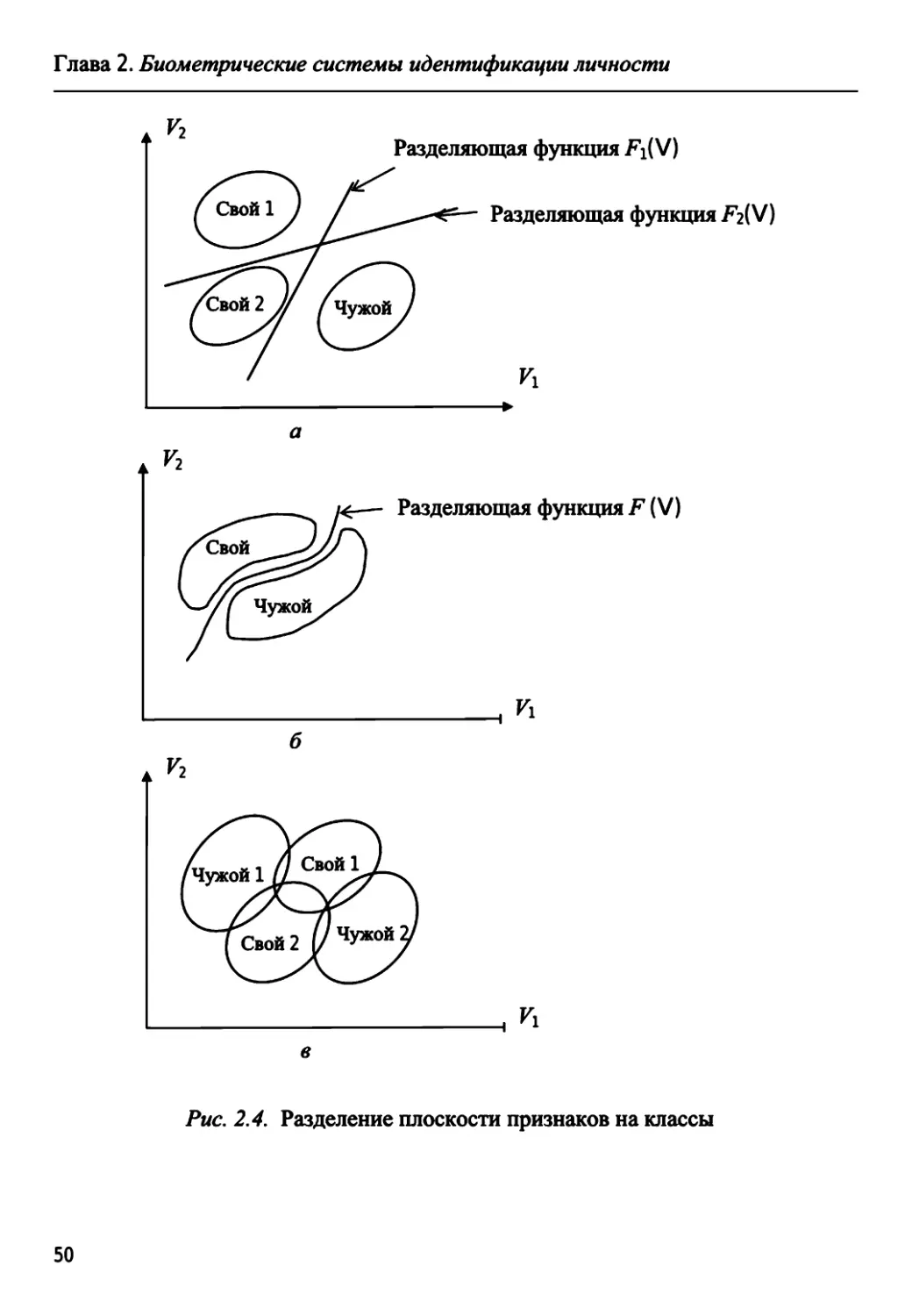

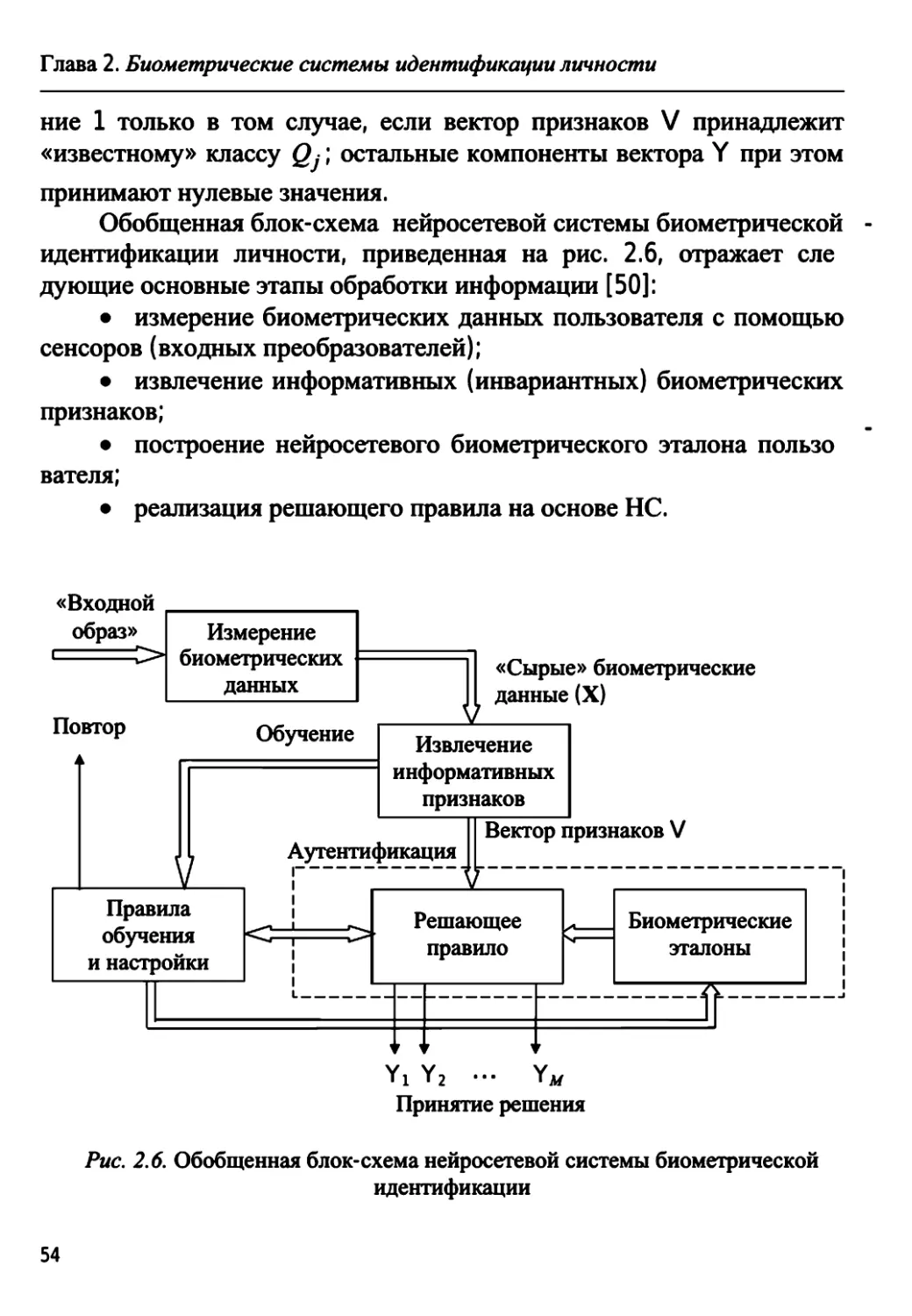

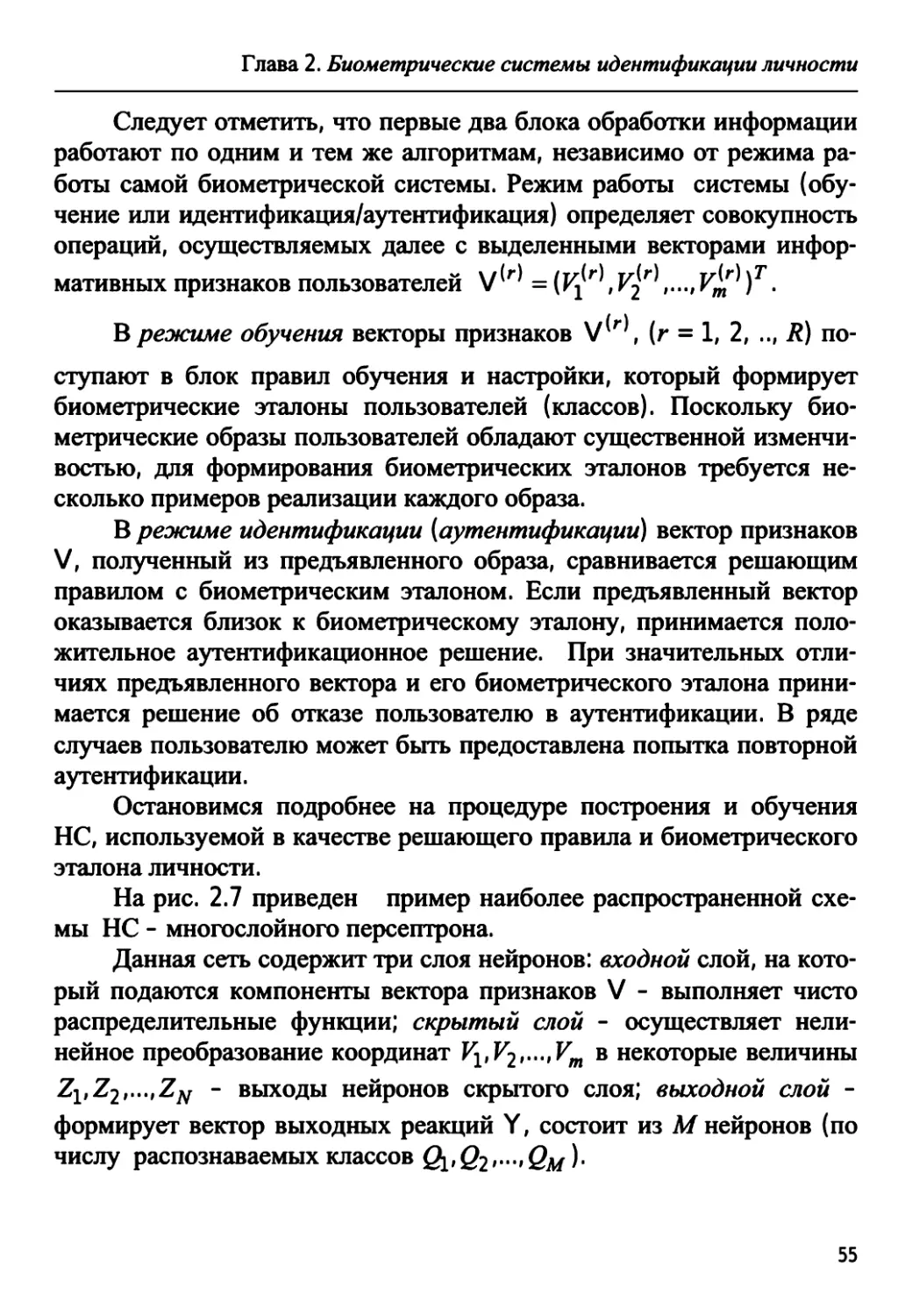

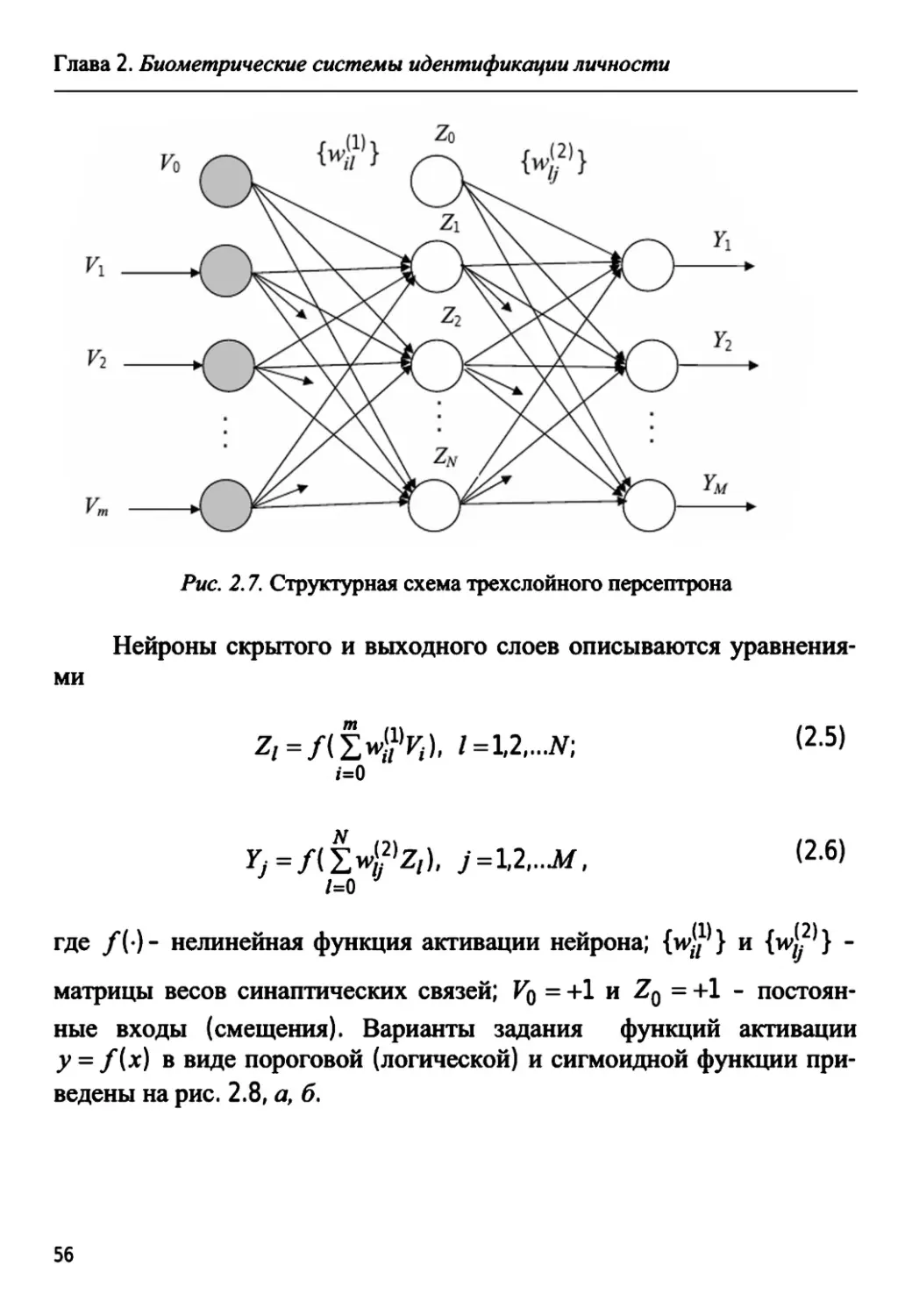

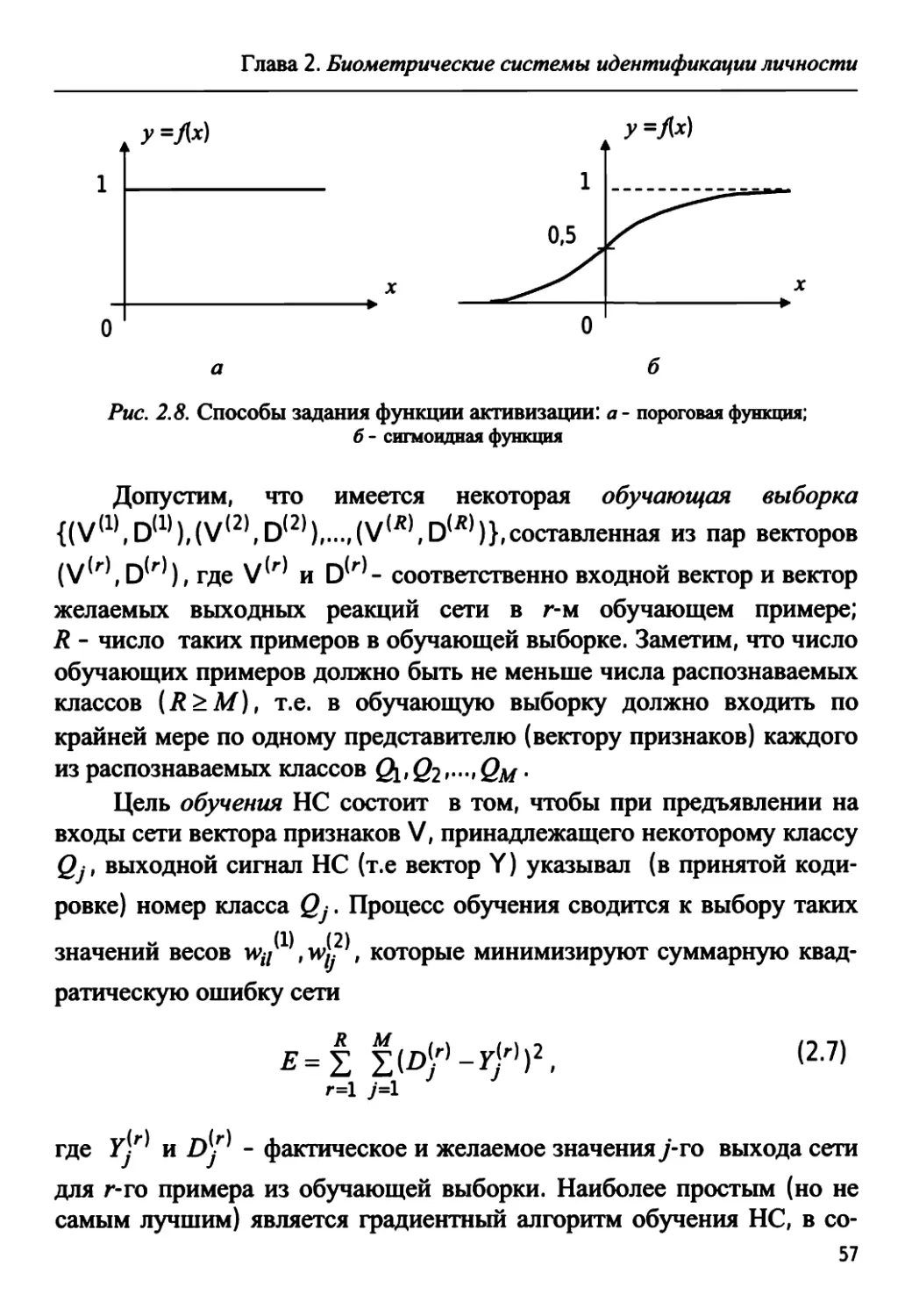

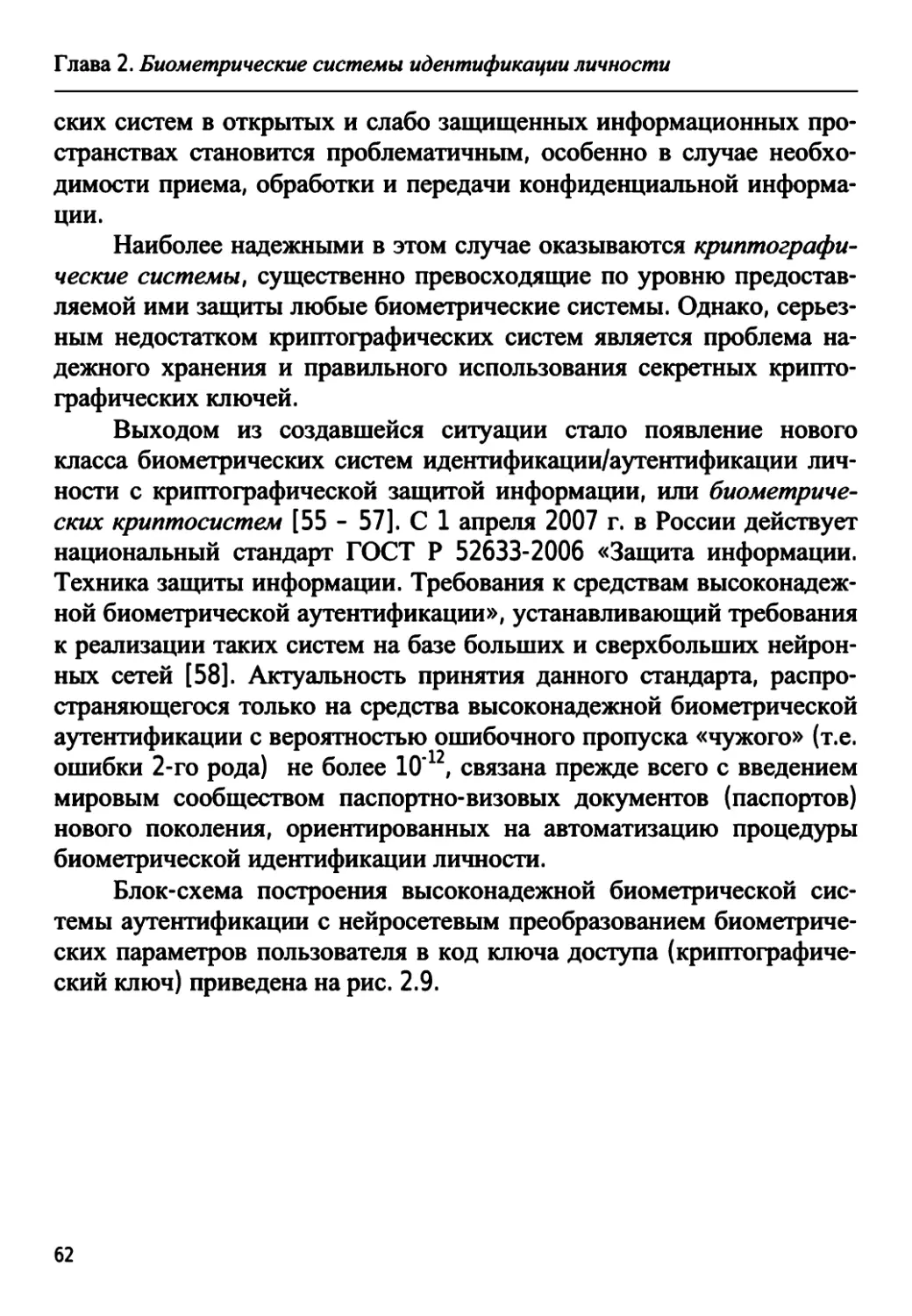

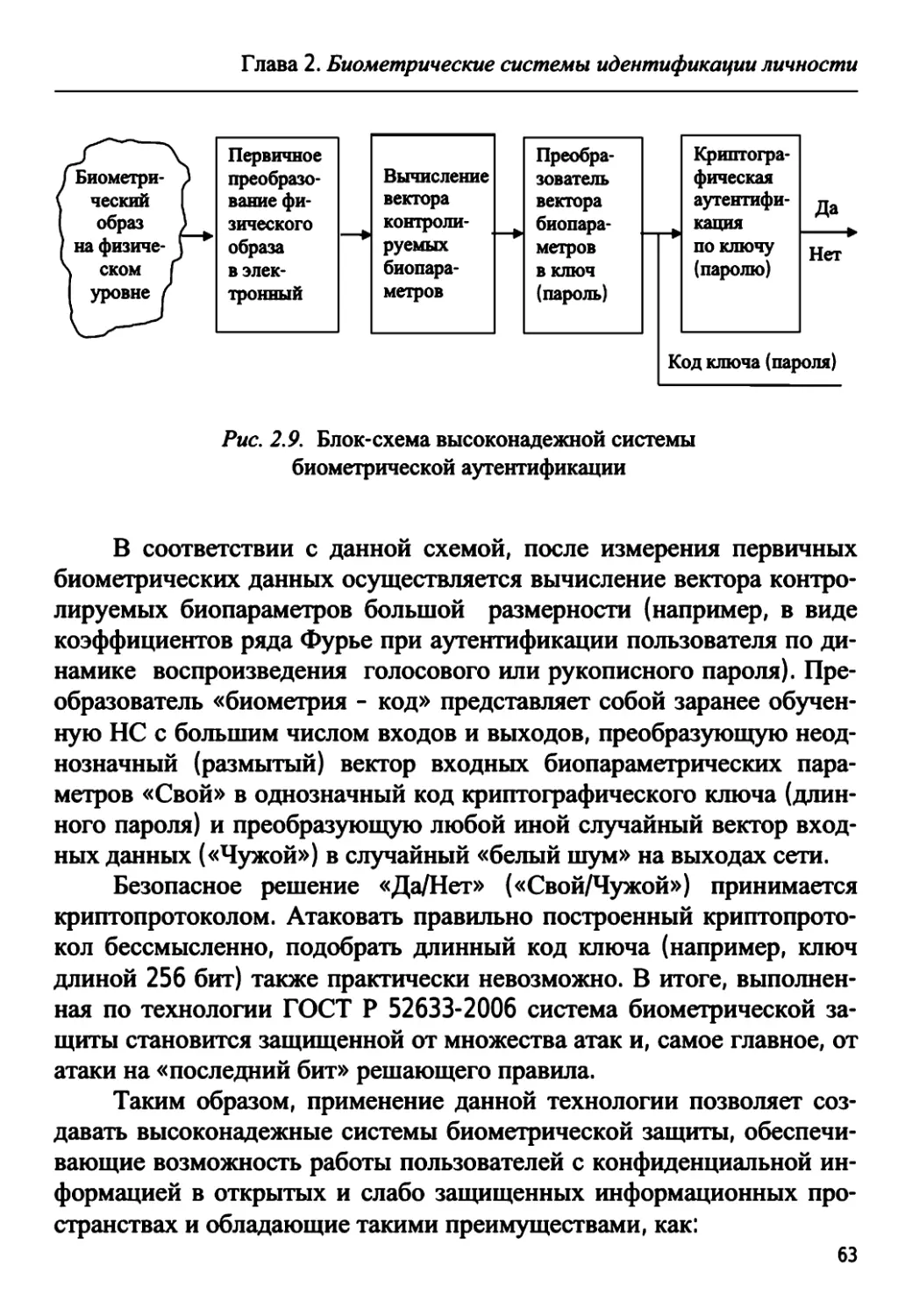

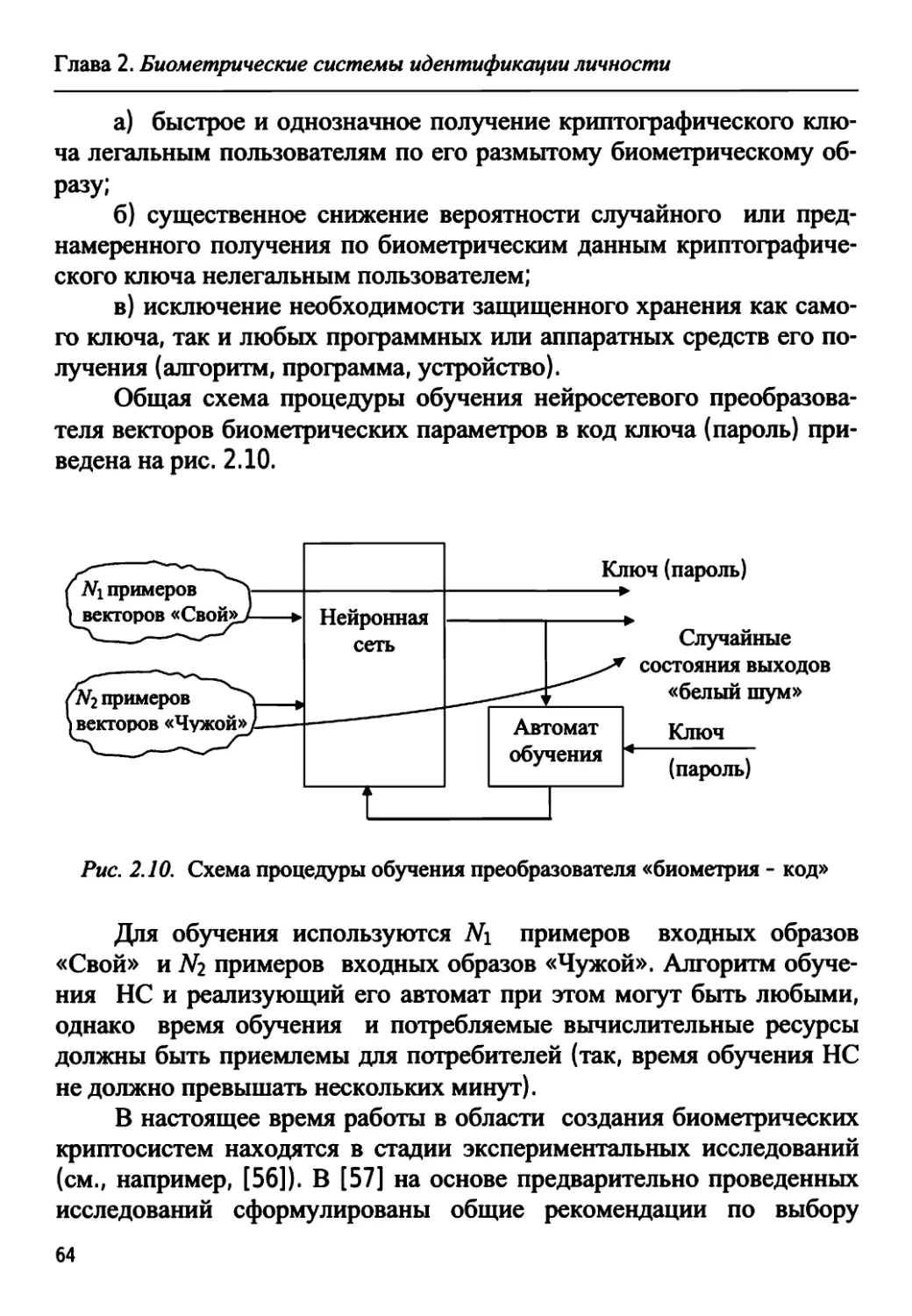

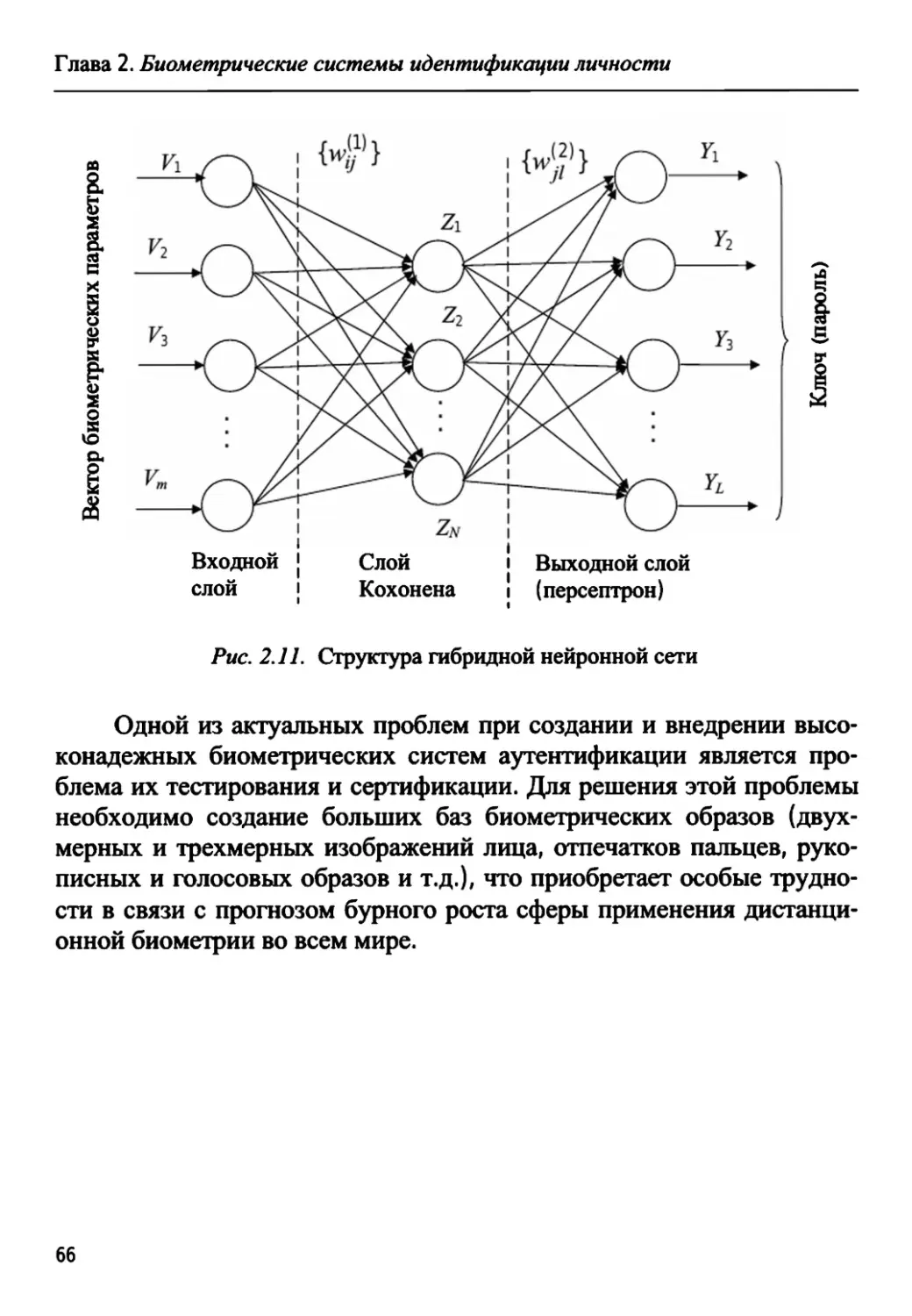

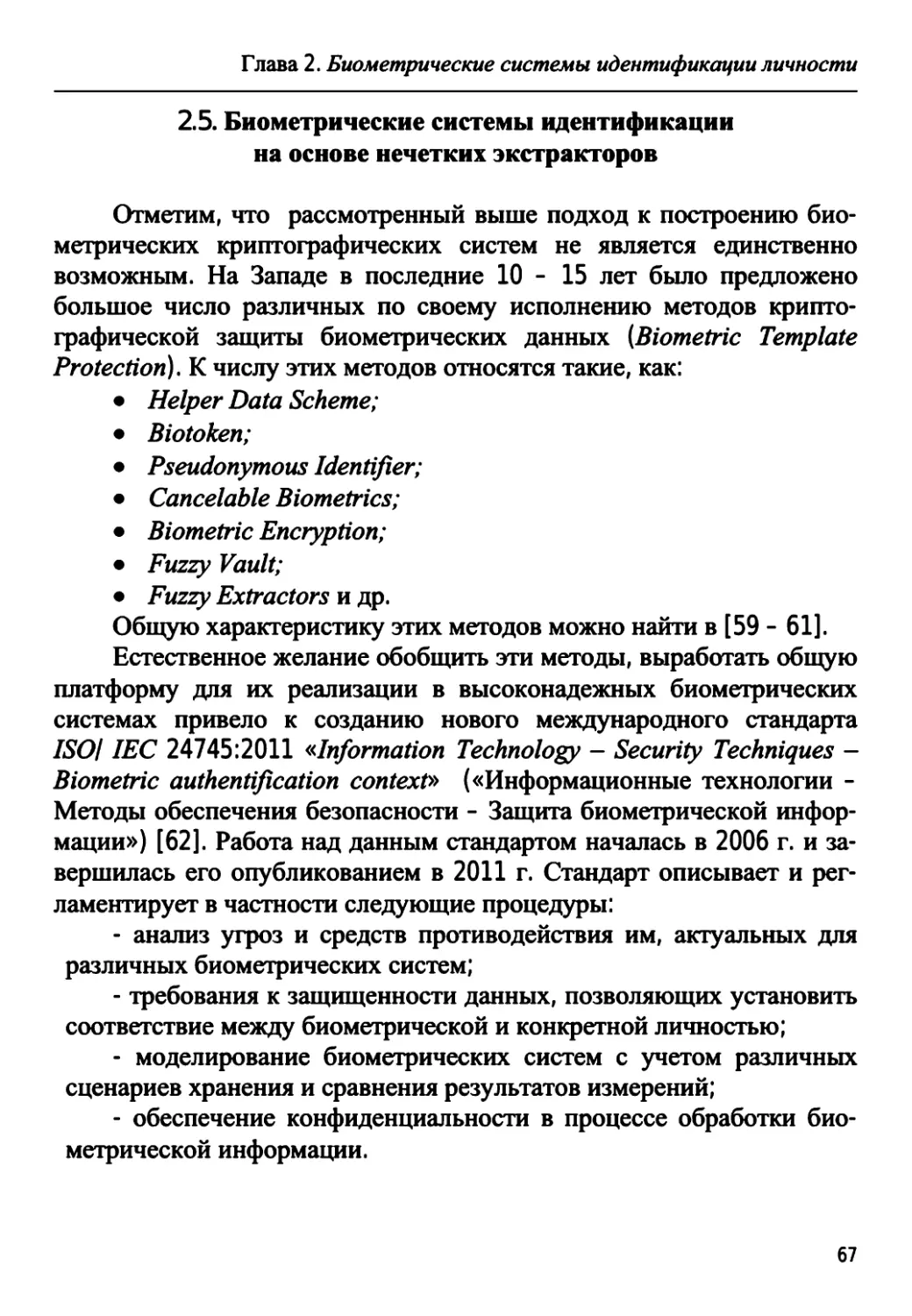

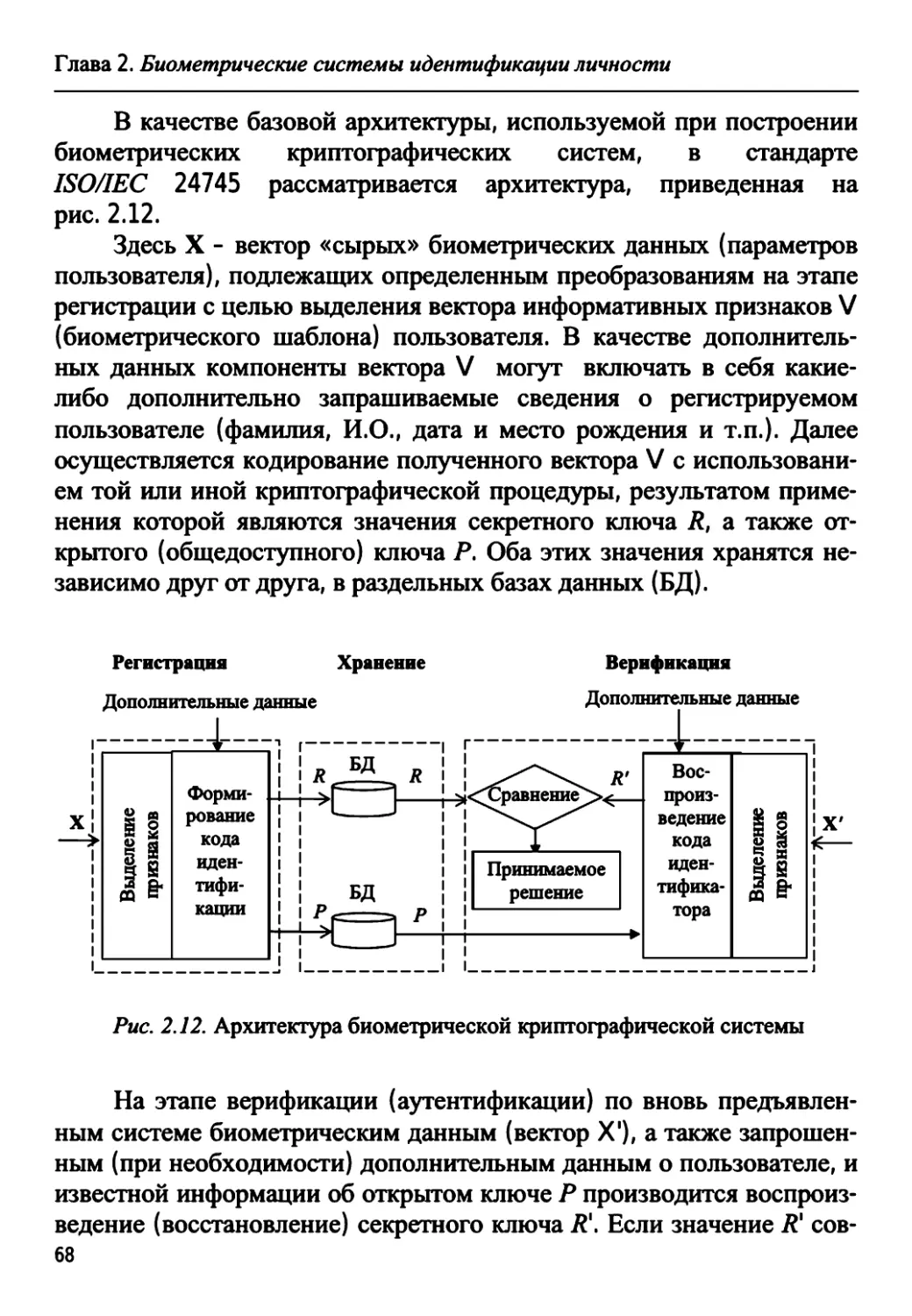

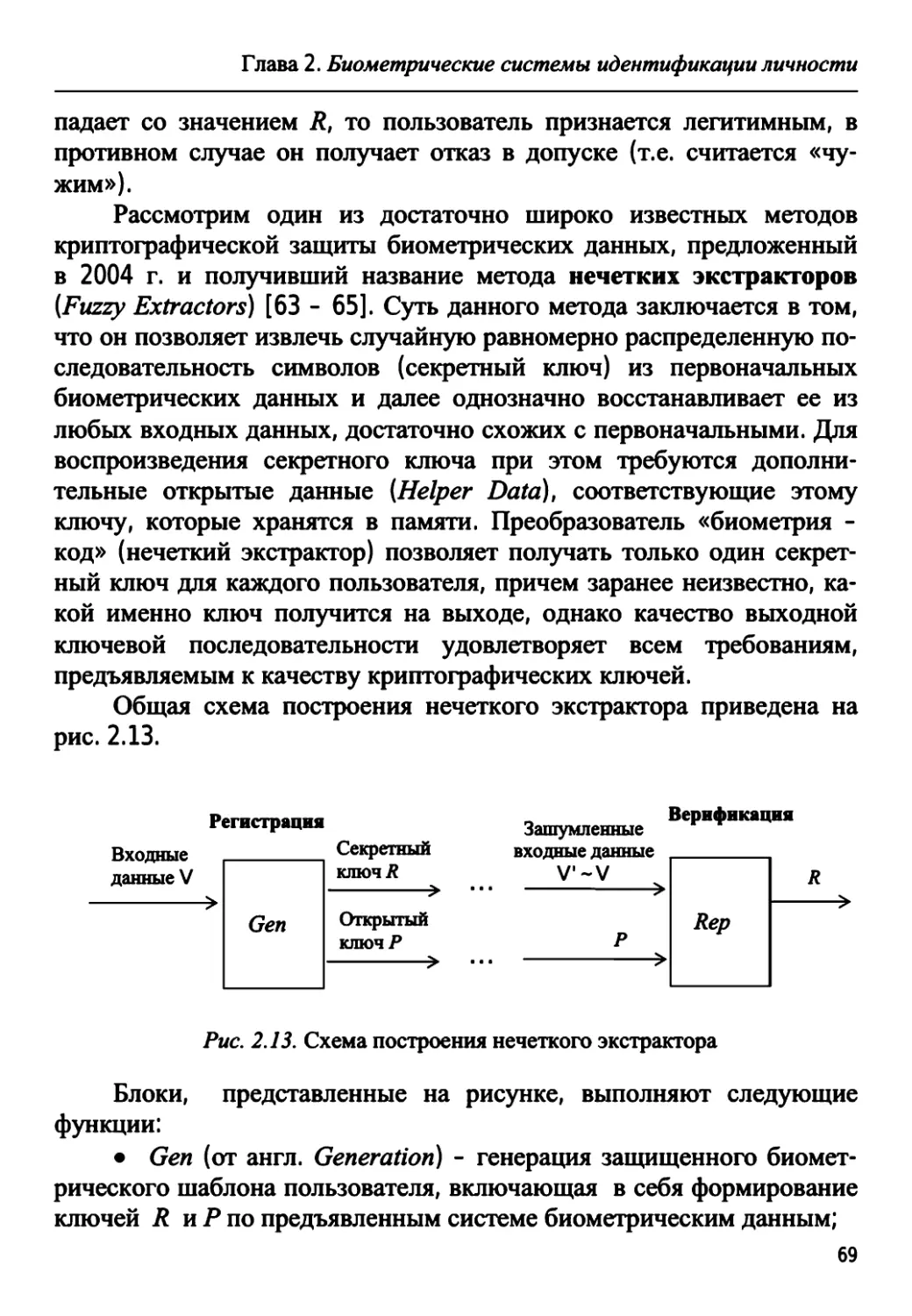

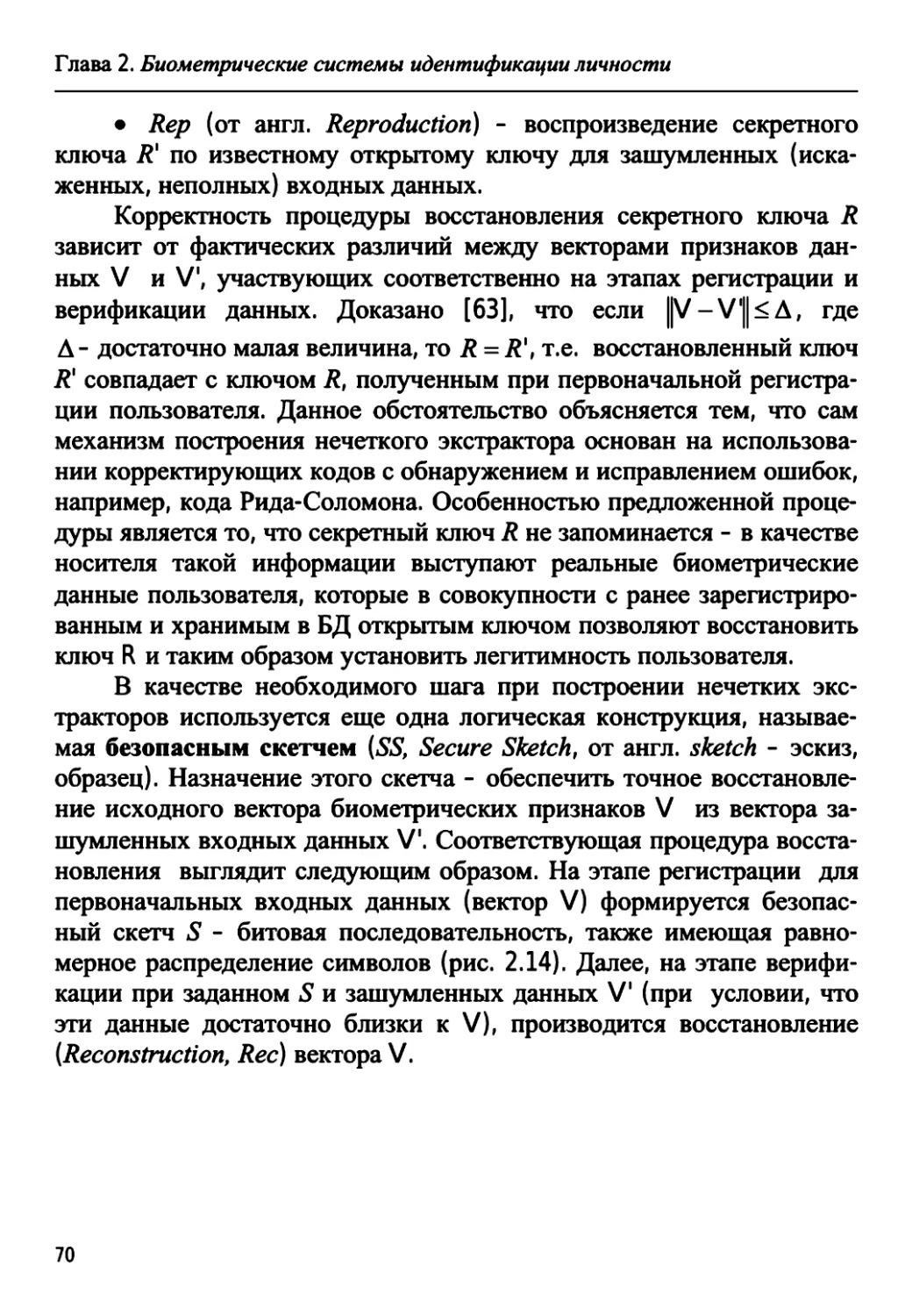

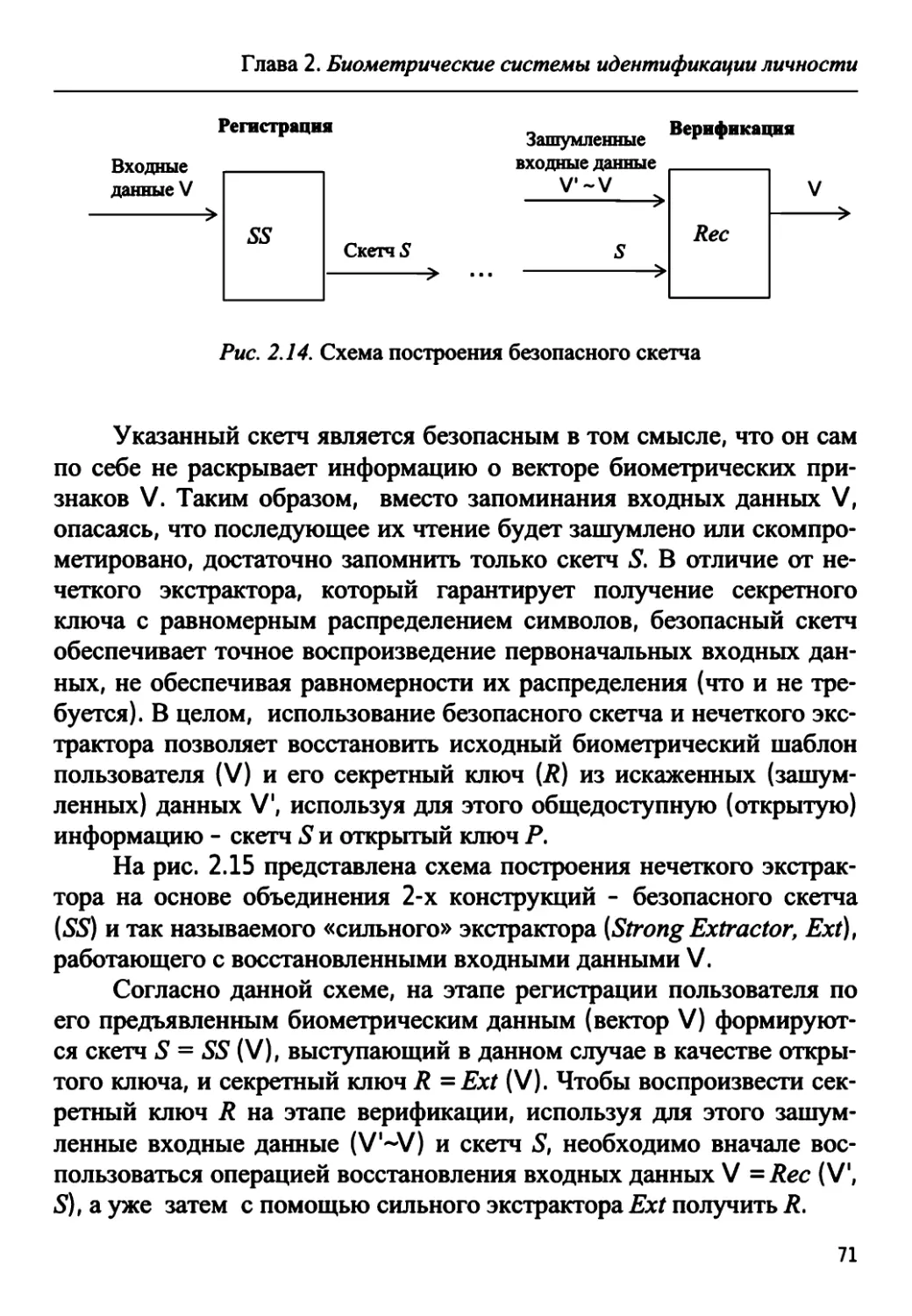

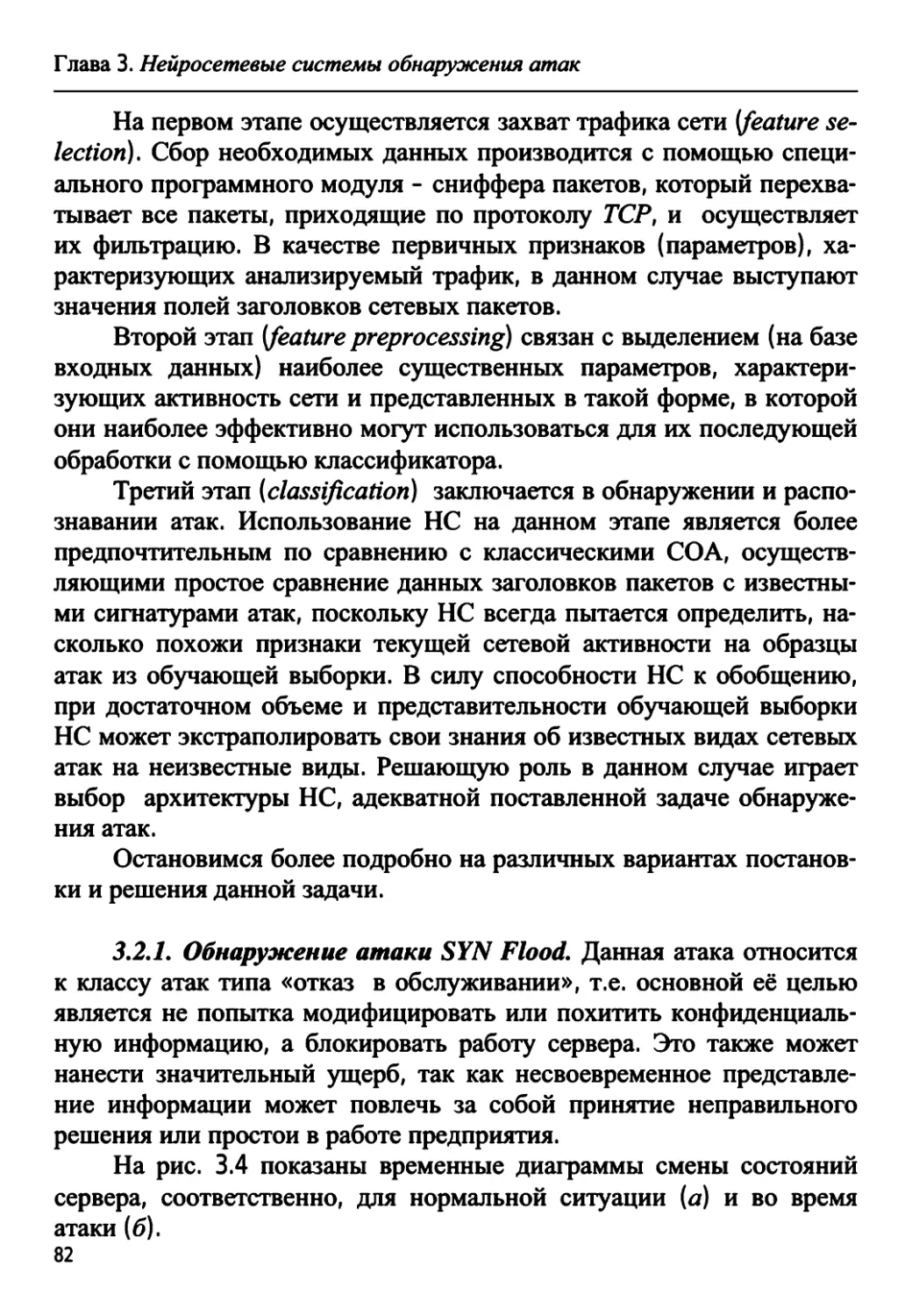

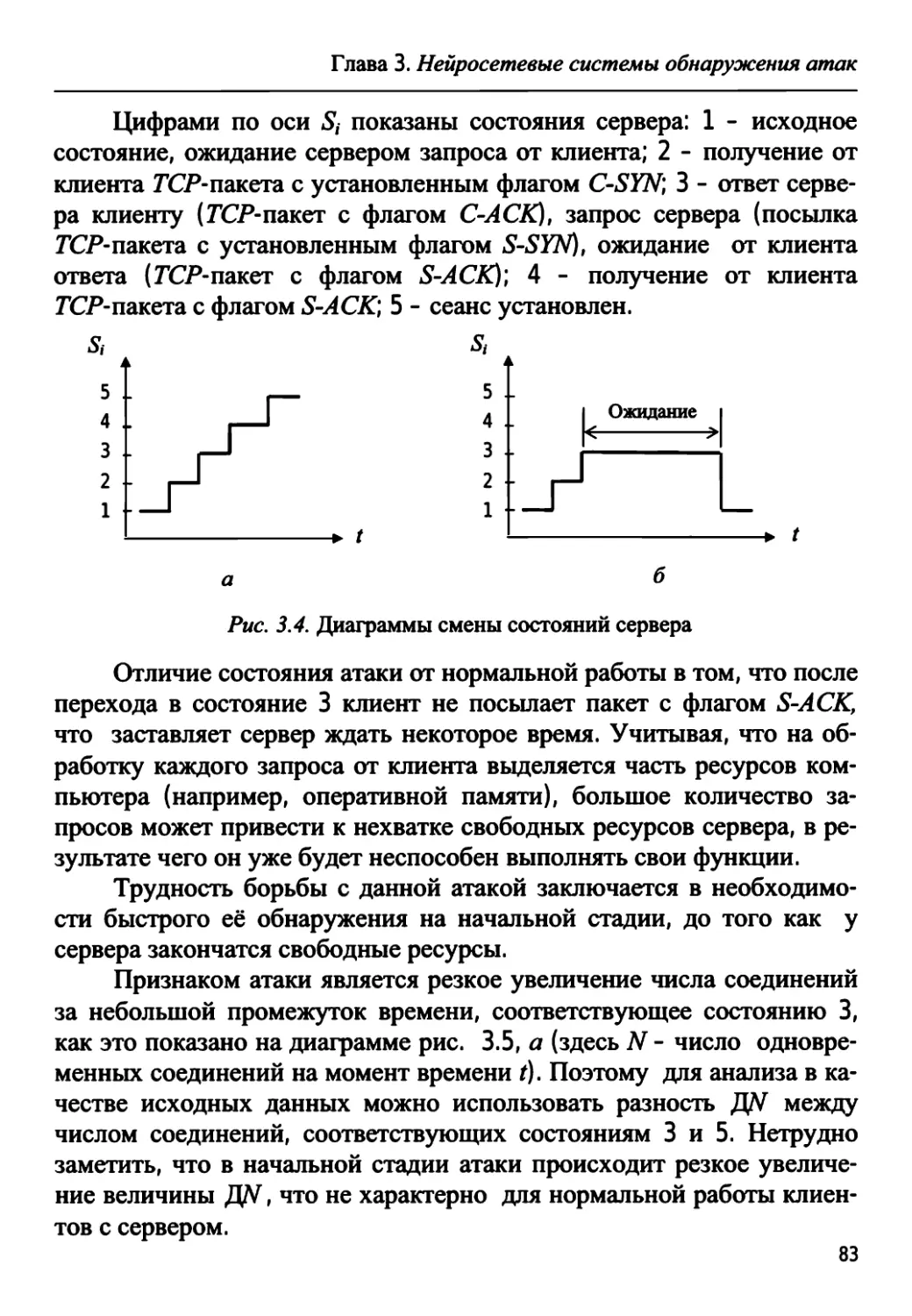

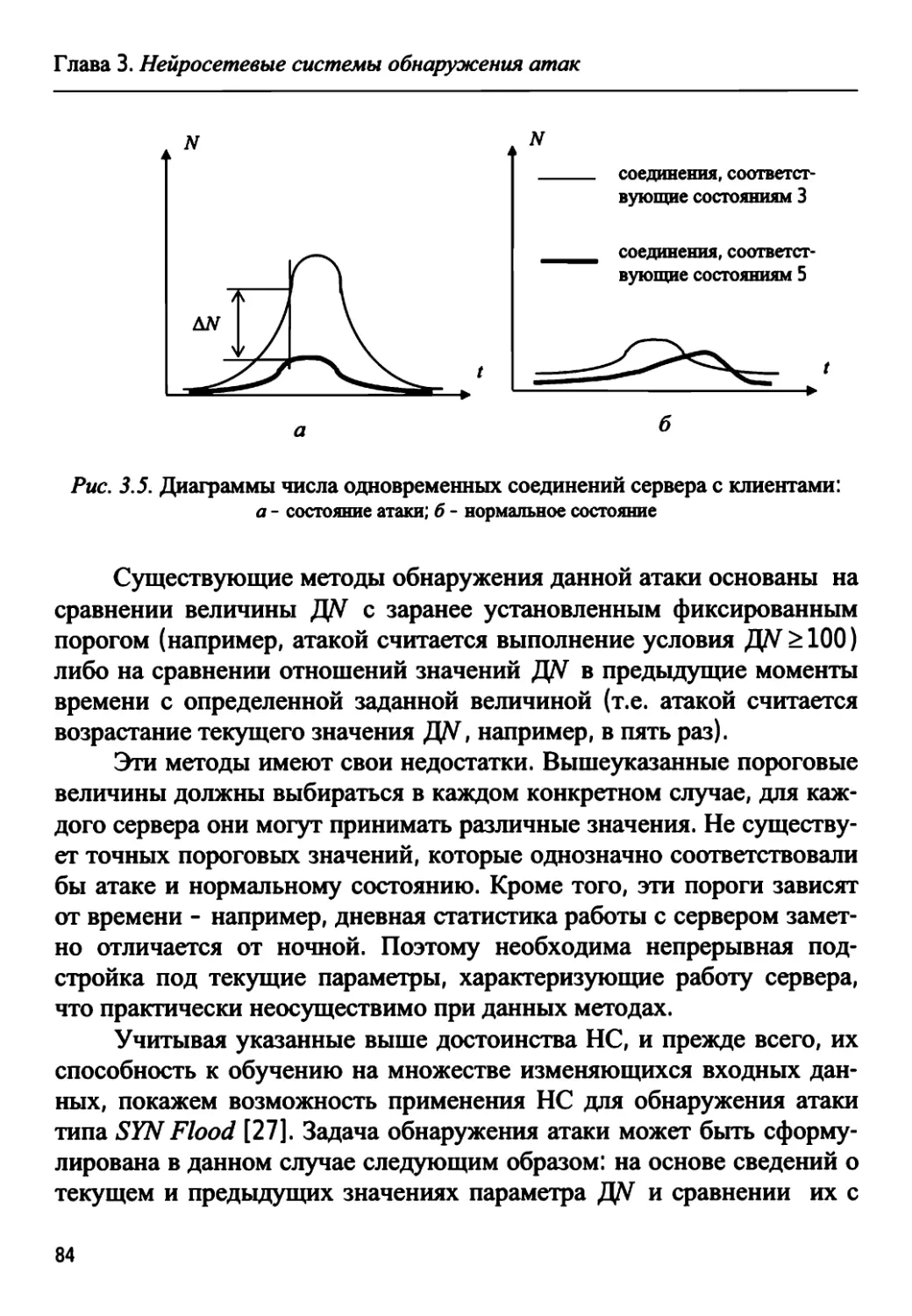

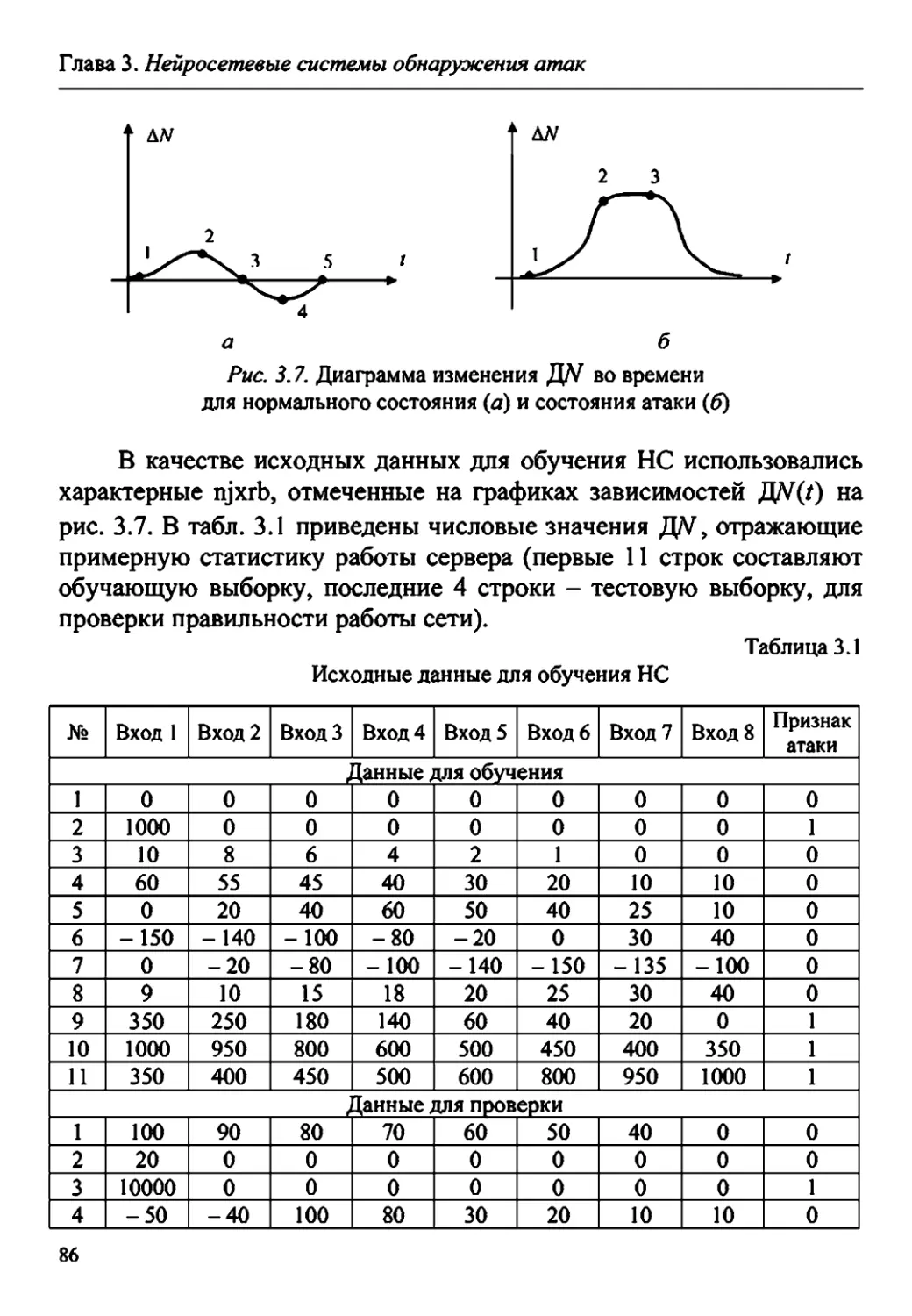

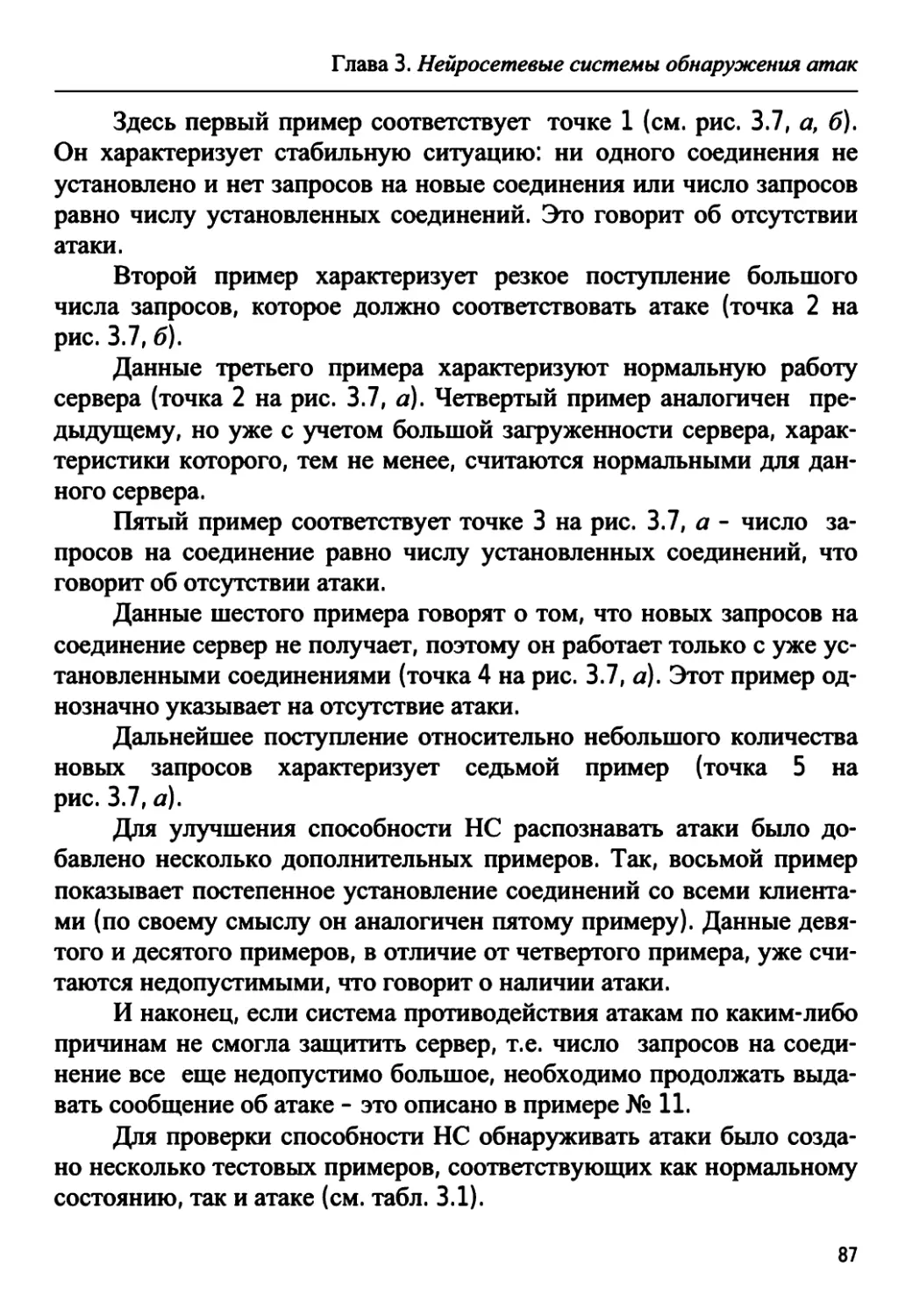

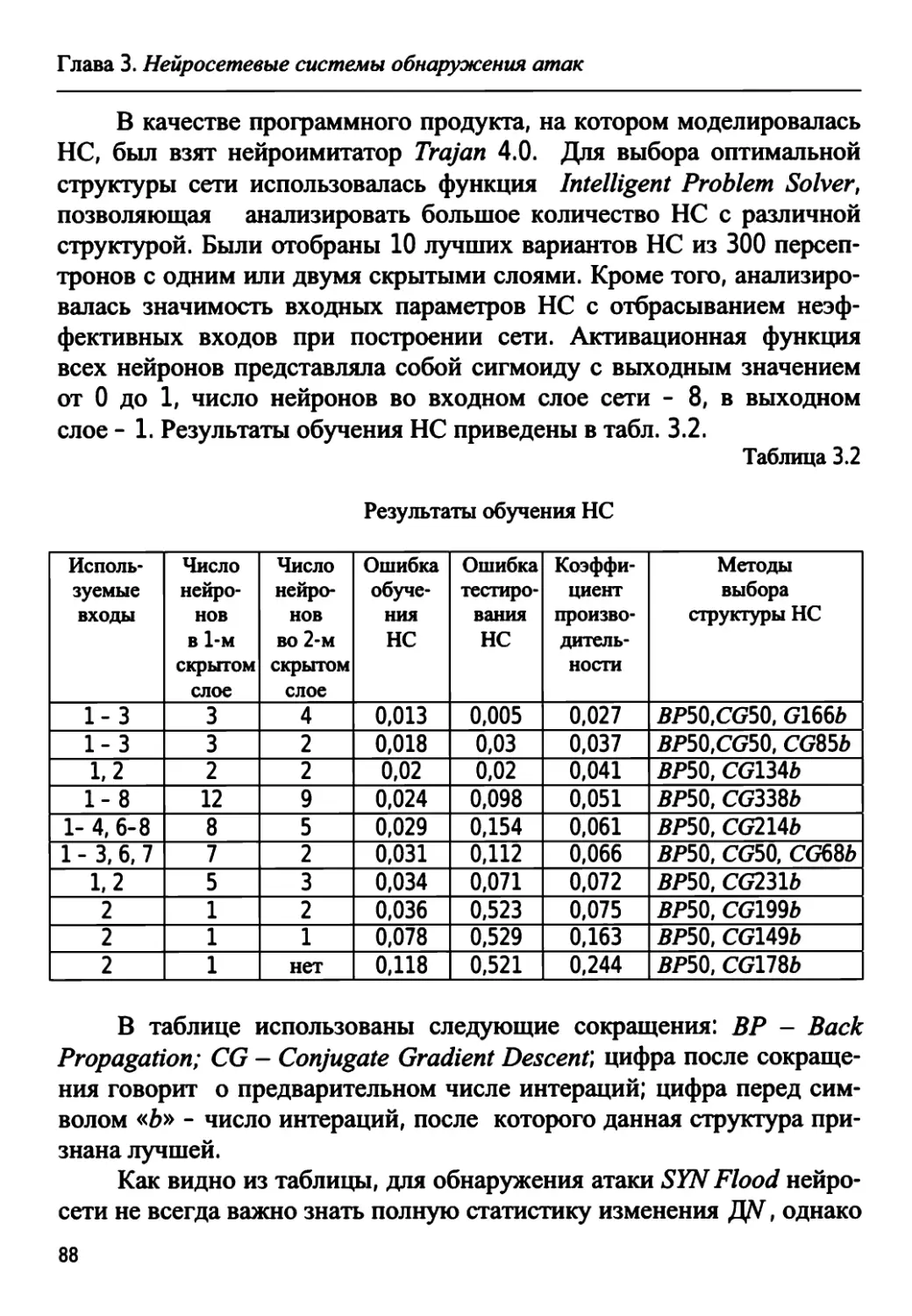

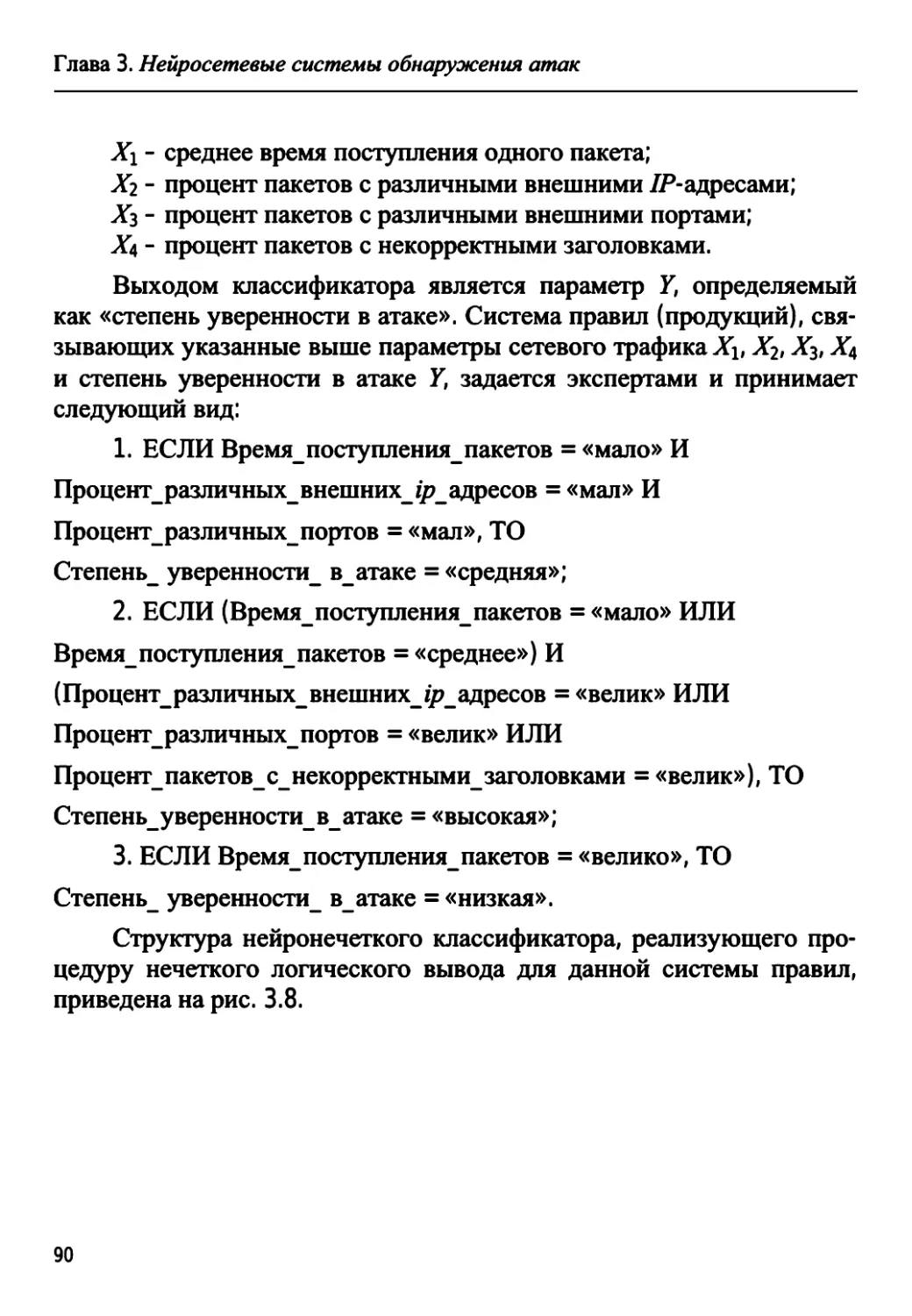

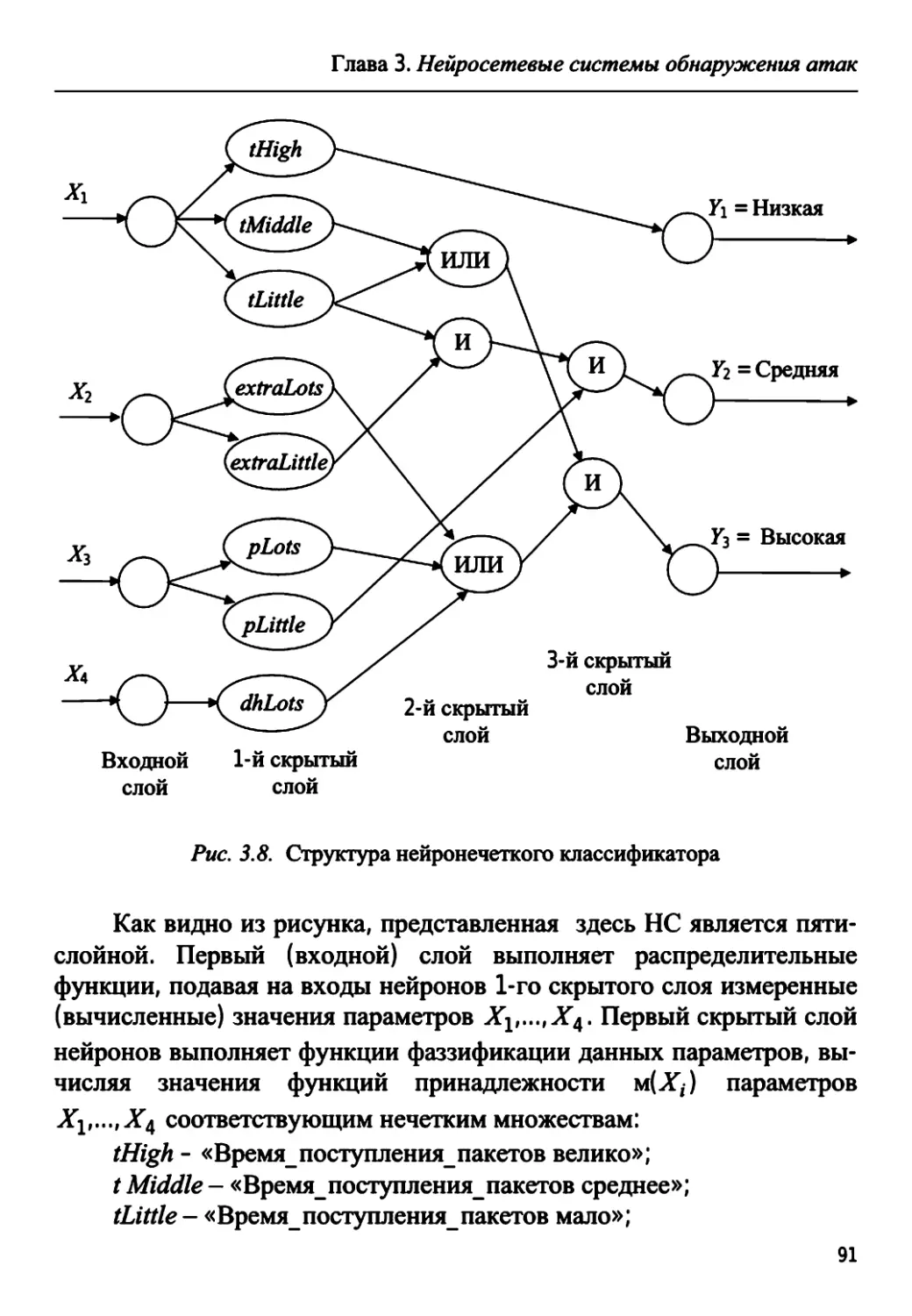

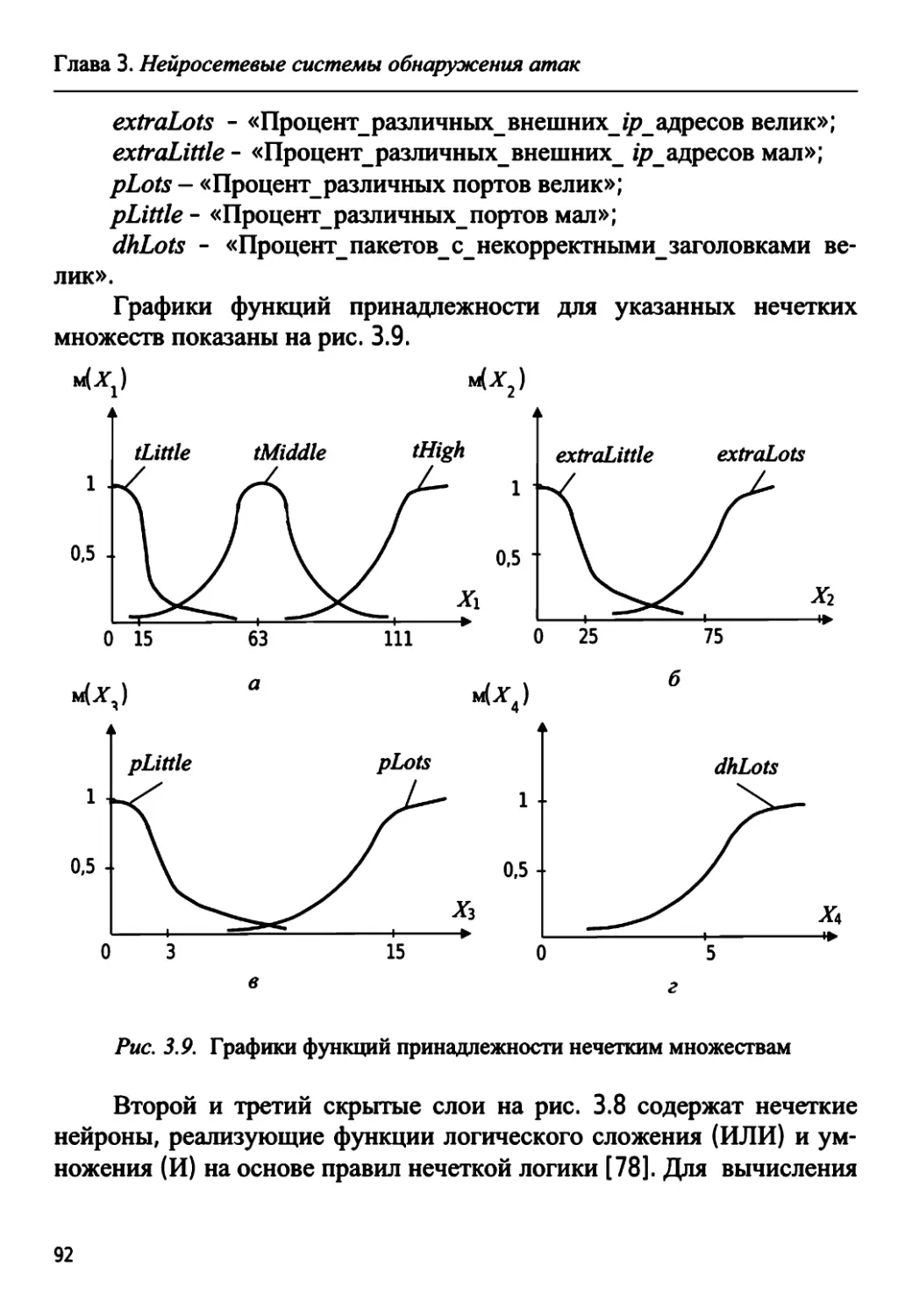

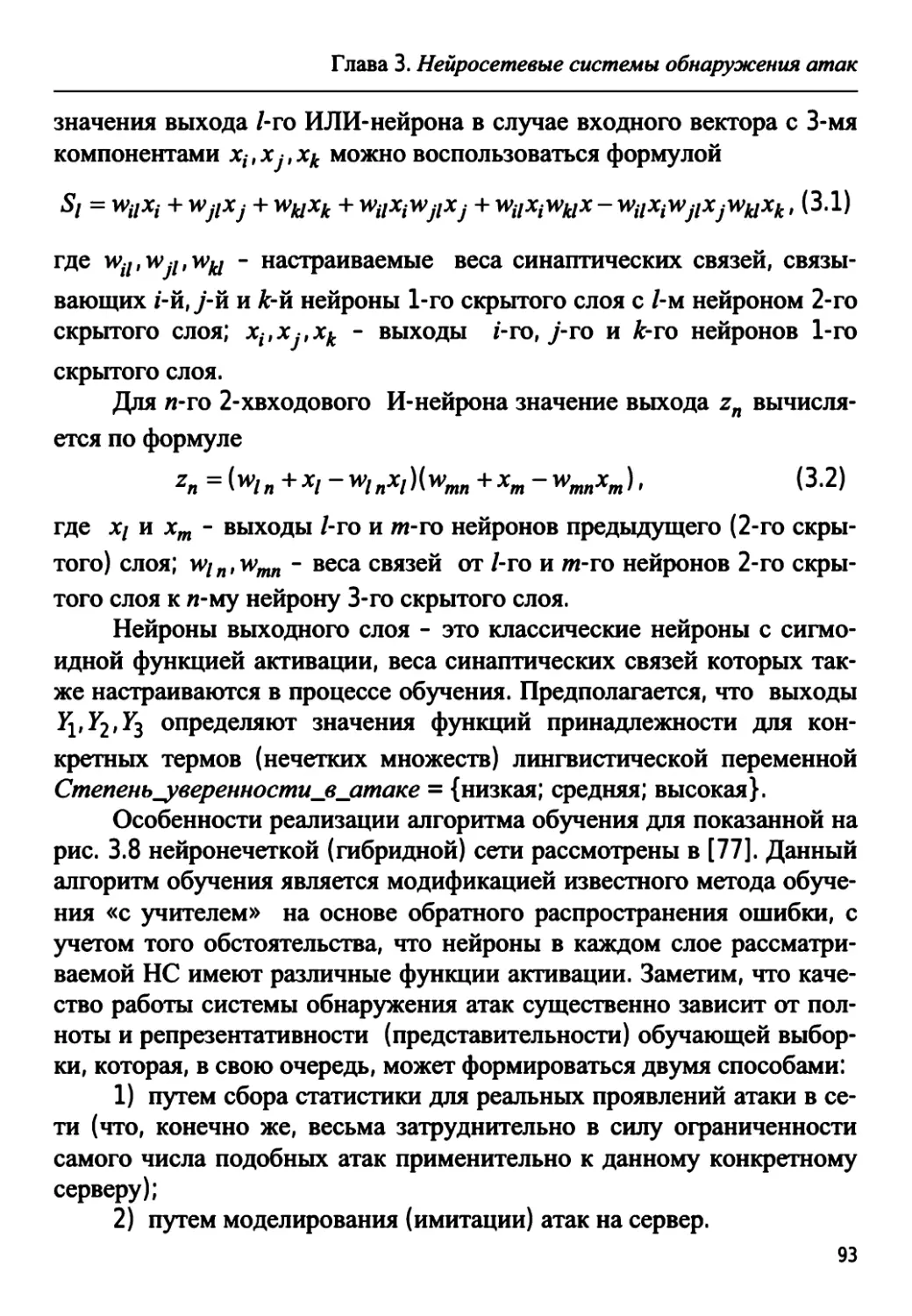

FRR, равном 1,3 %, лучший пальцевый сканер в режиме верификации