Автор: Рутковская Д. Пилиньский М. Рутковский Л.

Теги: эргономика программирование программное обеспечение компьютерные науки нейронные сети переводная литература издательство горячая линия телеком

ISBN: 5-93517-103-1

Год: 2006

Д. Рутковская

М. Пилиньский

Л. Рутковский

Нейронные сети,

генетические алгоритмы

и нечеткие системы

Д.Рутковская

М.Пилиньский

Л.Рутковский

Нейронные сети,

генетические алгоритмы

и нечеткие системы

WYDAWNICTWO

NAUKOWE

PWN

WARSZAWA

LODZ

1999

Sied

neuronowe,

algorytmy

genetyczne

i systemy

rozmyte

Danuta Rutkowska

Maciej Pilinski

Leszek Rutkowski

Д. Рутковская

М. Пилиньский

Л. Рутковский

Нейронные сети,

генетические алгоритмы

и нечеткие системы

Перевод с польского И. Д. Рудинского

Москва

Горячая линия-Телеком

2006

ББК 30.17

Р90

Рутковская Д., Пилиньский М., Рутковский Л.

Р90 Нейронные сети, генетические алгоритмы и нечеткие

системы: Пер. с польск. И. Д. Рудинского. - М.: Горячая линия -

Телеком, 2006. - 452 с.: ил.

ISBN 5-93517-103-1.

Книга посвящена вопросам «интеллектуальных вычислений». Содер-

жит базовые знания о генетических алгоритмах, эволюционном програм-

мировании, нечетких системах, а также о связях этих направлений с ней-

ронными сетями.

Для научных и инженерно-технических работников в области инфор-

матики и вычислительной техники, занимающихся созданием и использо-

ванием интеллектуальных систем, а также аспирантов и студентов раз-

личных специальностей в области компьютерных технологий.

ББК 30.17

Адрес издательства в Интернет www.techbook.ru

e-mail: radios_hl@mtu-net.ru

Научное издание

Рутковская Данута

Пилиньский Мачей

Рутковский Лешек

НЕЙРОННЫЕ СЕТИ, ГЕНЕТИЧЕСКИЕ АЛГОРИТМЫ

И НЕЧЕТКИЕ СИСТЕМЫ

Редактор А. С. Попов

Компьютерная верстве Т. С. Левыкиной

Корректор Р. И. Голубева

Обложка художника В. Г. Ситникова

ЛР № 071825 от 16 марта 1999 г.

Подписано в печать 14.11.05. Формат 60x90/16 Печать офсетная

Уч.-изд. л. 28,25. Тираж 1000 экз. Изд. № 103

ISBN 5-93517-103-1 (рус.) © Издательство Wydawnictwo

ISBN 83-01-12304-4 (польск.) © Naukowe PWN, 1997, 1999, 2004

© Рудинский И. Д., перевод с польск., 2004

© Оформление издательства

«Горячая линия-Телеком», 2006

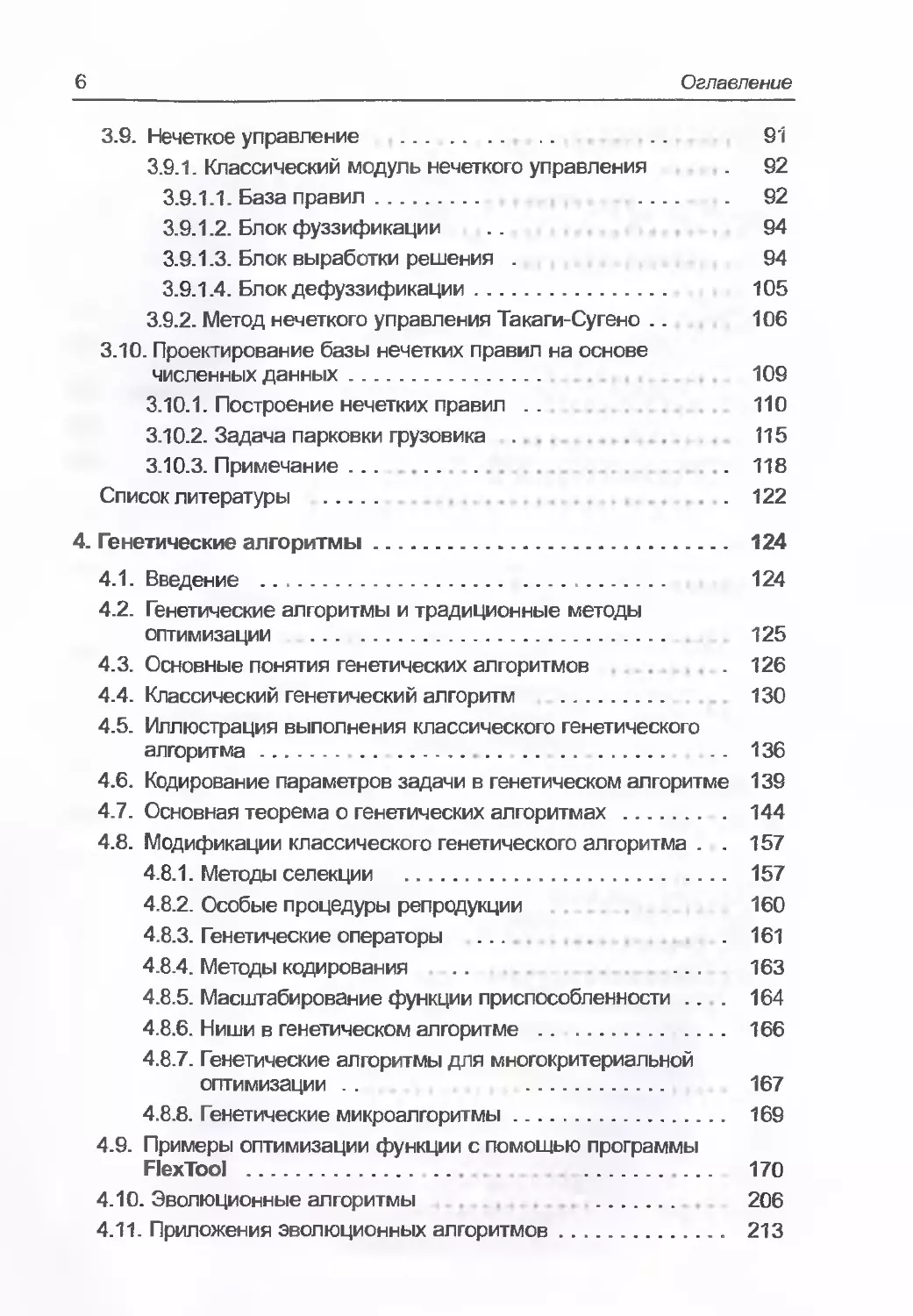

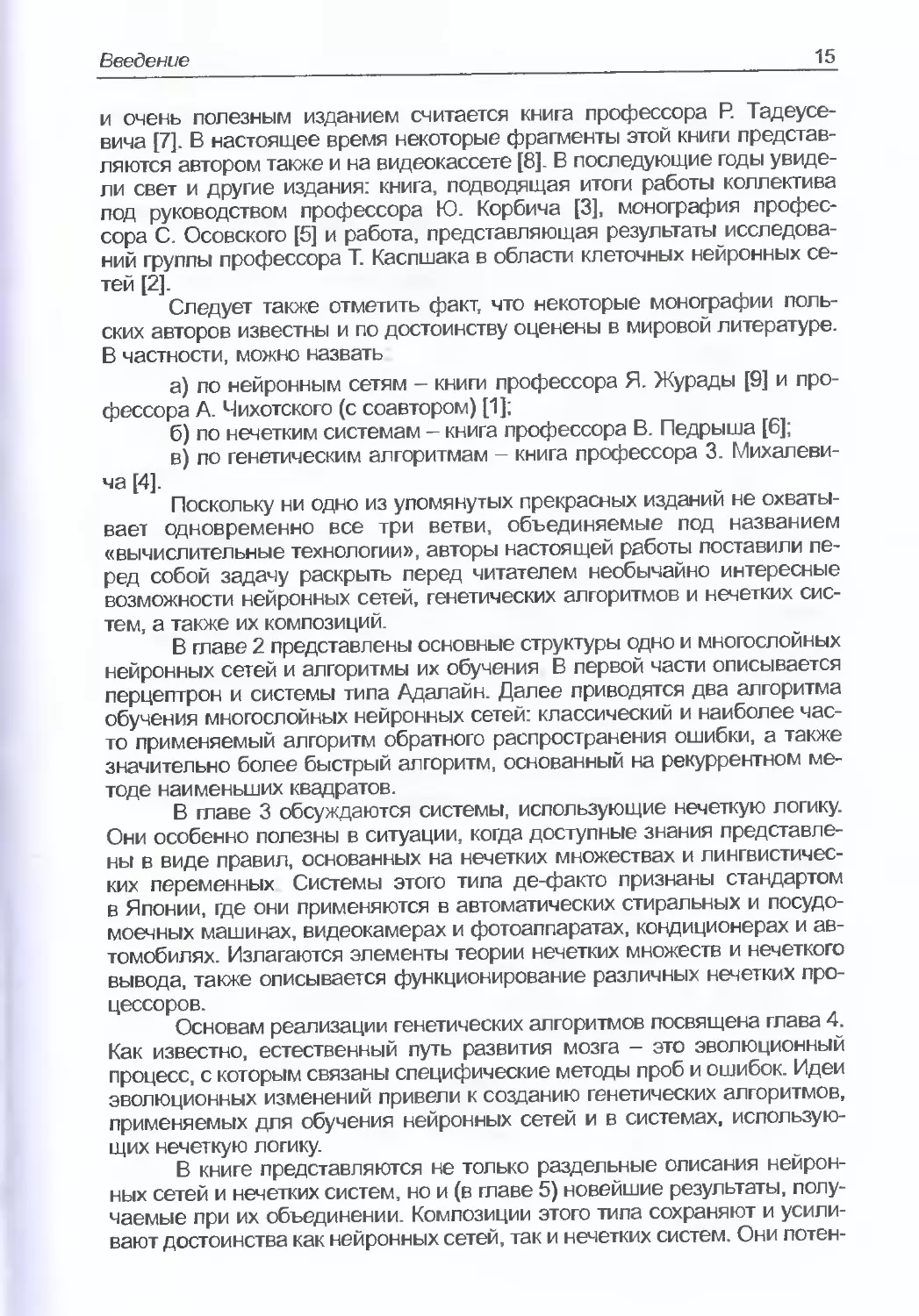

Оглавление

Предисловие............................................. 9

Предисловие к русскому изданию.......................... 12

1. Введение............................................ 14

Список литературы............................... ... 16

2. Многослойные нейронные сети и алгоритмы их обучения 18

2.1. Введение........................... 18

2.2. Нейрон и его модели 18

2.3. Персептрон........................................ 21

2.4. Системы типа Адалайн . 25

2.4.1. Линейный взвешенный сумматор ... 26

2.4.2. Адаптивный линейный взвешенный сумматор .. 30

2.4.3. Адаптивный линейный взвешенный сумматор

с сигмоидой на выходе ......................... 31

2.5. Алгоритм обратного распостранения ошибки ......... 33

2.6. Применение рекуррентного метода наименьших квадратов

для обучения нейронных сетей............. .. 37

Список литературы........

3 Нечеткие множества и нечеткий вывод

3.1. Введение....................................

3.2. Основные понятия и определения теории нечетких

множеств..........................................

3.3. Операции на нечетких множествах ..

3.4. Принцип расширения ..

3.5. Нечеткие числа ....

3.6. Треугольные нормы ...........

3.7. Нечеткие отношения и их свойства .

3.8. Нечеткий вывод..............................

3.8.1. Основные правила Вывода в двоичной логике...

3.8.2. Основные правила вывода в нечеткой логике.. .

3.8.2.1. Обобщенное нечеткое правило modus ponens.

3.8.2.2. Обобщенное нечеткое правило modus tollens.

3.8.3. Правила нечеткой импликации.............

§о2322ыыоои!оо2оЗсл ui « ы

Оглавление

3.9. Нечеткое управление ................................... 91

3.9.1. Классический модуль нечеткого управления 92

3.9.1.1. База правил............................... 92

3.9.1.2. Блок фуззификации 94

3.9.1.3. Блок выработки решения . 94

3.9.1.4. Блок дефуззификации........................ 105

3.9.2. Метод нечеткого управления Такаги-Сугено .. 106

3.10. Проектирование базы нечетких правил на основе

численных данных....................... 109

3.10.1. Построение нечетких правил . . 110

3.10.2. Задача парковки грузовика 115

3.10.3. Примечание................................... .118

Список литературы ......................................... .122

4. Генетические алгоритмы............................. 124

4.1. Введение ............................................. 124

4.2. Генетические алгоритмы и традиционные методы

оптимизации ............................................. 125

4.3. Основные понятия генетических алгоритмов .126

4.4. Классический генетический алгоритм ................... 130

4.5. Иллюстрация выполнения классического генетического

алгоритма............................................... 136

4.6. Кодирование параметров задачи в генетическом алгоритме 139

4.7. Основная теорема о генетических алгоритмах....... 144

4.8. Модификации классического генетического алгоритма . . 157

4.8.1. Методы селекции ............................... 157

4.8.2. Особые процедуры репродукции 160

4.8.3. Генетические операторы ... .161

4.8.4. Методы кодирования .. ... 163

4.8.5. Масштабирование функции приспособленности ... 164

4.8.6. Ниши в генетическом алгоритме ................ 166

4.8.7. Генетические алгоритмы для многокритериальной

оптимизации . . 167

4.8.8. Генетические микроалгоритмы............... 169

4.9. Примеры оптимизации функции с помощью программы

FlexTool .............................................. 170

4.10. Эволюционные алгоритмы 206

4.11. Приложения эволюционных алгоритмов.................. 213

Оглавление

4.11.1. Примеры оптимизации функции с помощью

программы Evolver ................................. 214

4.11.2. Решение комбинаторных задач с помощью

программы Evolver.................................. 246

4.12. Эволюционные алгоритмы в нейронных сетях ....... 250

4.12 1. Независимое применение генетических алгоритмов

и нейронных сетей ................................. 252

4.12.2 . Нейронные сети для поддержки генетических

алгоритмов .................................... . 252

4.12.3 . Генетические алгоритмы для поддержки

нейронных сетей ................................... 253

4.12.4 . Применение генетических алгоритмов для

обучения нейронных сетей........................... 256

4.12.5 . Генетические алгоритмы для выбора топологии

нейронных сетей ................................... 256

4.12.6 . Адаптивные взаимодействующие системы ... 257

4.12.7 . Типовой цикл эволюции ................... 257

4.12.7.1. Эволюция весов связей.....

4.12.7.2. Эволюция архитектуры сети .. .....

4.12.7.3. Эволюция правил обучения ...............

4.13. Примеры моделирования эволюционных алгоритмов

в приложении к нейронным сетям .........................

4.13.1. Программы Evolver и BrainMaker......

4.13.2. Программа GTO ...................

Список литературы ......................

5. Модули нечетко-нейронного управления ..................

5.1. Модуль нечеткого управления со структурой,

определенной в процессе дефуззификации ....

5.1.1. Введение................

5.1.2. Конструкция модуля ..........

5.1.3. Структура модуля...............

5.1.4. Использование алгоритма обратного

° ш о m m s о о oqo?

счсчсч CNCNCNM м п я я я

распространения ошибки ..................... 313

5.1.5. Модификации модуля ....................... 320

5.1.6. Применение модуля нечеткого управления для

прогнозирования случайных временных рядов .... 322

5.1.7. Применение модуля нечеткого управления для

решения задачи парковки грузовика................ 326

5.1.8. Примечание ............................... 330

Оглавление

5.2. Представление модуля нечеткого управления в виде

стандартной нейронной сети............................ 330

5.3. Модуль нечеткого управления с нейронной сетью для

выполнения дефуззификации ............................ 333

5.3.1. Введение......... 333

5.3.2. Конструкция модуля .. 334

5.3.3. Структура модуля .......................... 335

5.3.4. Алгоритмы обучения модуля ................. 337

5.3.5. Решение задачи стабилизации перевернутого

маятника.......................................... 342

5.3.6. Примечание ................................ 348

5.4. Модуль нечеткого управления с возможностью коррекции

правил ...............................................

5.4.1. Введение..............................

5.4.2. Фаза обучения на основе самоорганизации ...

5.4.3. Фаза обучения с учителем...................

5.4.4. Примечание ...........................

5.5. Модуль нечеткого управления типа Такаги-Сугено:

случай независимых лингвистических переменных ...

5.5.1. Введение . .. .............................

5.5.2. Нейронная реализация функции принадлежности ..

5.5.3. Модули Такаги-Сугено .

5.5.4. Реализация условий.........

5.5.5. Реализация заключений......

5.5.6. Примечание ................................

5.6. Модуль нечеткого управления типа Такаги-Сугено:

случай зависимых лингвистических переменных .

5.6.1. Введение..............................

5.6.2. Нейронные сети для нечеткого вывода ..

5.6.3. Структура системы ...

5.6.4. Способ обучения.................

5.6.5. Решение задачи парковки грузовика ...

5.6.6. Примечание

Список литературы .........................

Предметный указатель..................................

шшш нш

Предисловие

Двадцатый век завершился под знаком революции в области обра-

ботки информации. Мы стали свидетелями как быстрого роста объема

доступных данных, так и увеличения скорости их обработки и передачи,

а также емкости запоминающих устройств. Отчетливо видно, что эти яв-

ления не только взаимосвязаны, но и усиливают друг друга. В ситуации

лавинобразного нарастания объемов информации и вычислительных

мощностей возникает очевидный вопрос каким образом можно улучшить

наши способности к познанию окружающего мира, имея в наличии столь

большие и непрерывно растущие технические возможности?

Помощь приходит со стороны апробированных классических мате-

матических методов, созданных трудами Ньютона, Лейбница, Эйлера

и других гениев прошлого, заложивших фундамент современных вычис-

лительных алгоритмов. Благодаря им у нас есть специализированные

вычислительные процедуры для распознавания образов и речи, для уп-

равления системами различных классов и решения иных аналогичных

проблем. Независимые от этого направления исследования в области ис-

кусственного интеллекта привели к созданию экспертных и прогностиче-

ских систем, основанных на символьной обработке и использующих базы

правил. Однако все перечисленные выше подходы предполагают исполь-

зование либо узкоспециализированных вычислительных методик, либо

специализированных баз знаний, чаще всего заключенных в жесткий кор-

сет двоичной логики. Еще одно ограничение на применение этих методов

связано с фактом, что они не допускают непосредственное решение за-

дач при использовании вычислительных систем с универсальной архи-

тектурой, общей для большинства практических приложений.

Таким образом, мы подходим к происхождению и сущности вычис-

лительных технологий, составляющих предмет настоящей книги. Эти тех-

нологии, объединяемые в англоязычной литературе под названием

Computational Intelligence, позволяют получать непрерывные или дис-

кретные решения в результате обучения по доступным имеющимся дан-

ным. Один из подклассов обсуждаемой группы методов составляют ней-

ронные сети, использующие стохастические алгоритмы для обучения мо-

дели с учителем или путем самоорганизации. Они предназначены для

обработки зашумленных цифровых данных, по которым алгоритмы обу-

чения выстраивают однонаправленные или рекуррентные модели инте-

ресующих нас процессов. Эти модели характеризуются регулярной струк-

турой, составленной из нелинейных элементов, объединенных разветв-

ленной сетью линейных соединений и часто дополняемой локальными

или глобальными обратными связями.

При моделировании процессов возможности нейронных сетей мо-

гут усиливаться за счет применения технологии обработки информации,

основанной на нечетких множествах и нечетком выводе. Этот метод свя-

зан с оцениванием функции принадлежности элементов к множествам

с помощью нечетких логических операторов. Предлагаемый подход не

только ослабляет требования к точности данных в процессе построения

10

Предисловие

модели, но и позволяет описать сложные системы с помощью перемен-

ных, значения которых определяются на интуитивном уровне. Возникаю-

щая в результате парадигма моделирования, управления, выработки ре-

шений и т.п. ведет к формированию лингвистических аргументов логиче-

ских функций.

Такие функции, описывающие реальные объекты, могут уточнять-

ся в процессе обучения по имеющимся данным. Другой подход состоит

в формировании правил вывода непосредственно в процессе обучения.

Этим и определяется взамопроникновение и комплементарность нейрон-

ных моделей и систем, базирующихся на нечеткой логике. Лингвистичес-

кие операторы, которые мы используем при повседневном общении,

и итерационный процесс обучения вместе ведут к интеллектуальным ло-

гикоалгебраическим моделям, определяемым понятием Computational

Intelligence (вычислительные технологии). Интеллектуальность в данном

случае понимается как способность применять знания, накопленные

в процессе обучения, как возможность генерировать правила вывода

и как умение обобщать информацию.

Важным классом алгоритмов обучения, обогативших нейронные

и нечеткие технологии, считаются эволюционные алгоритмы. Они опери-

руют популяциями хромосом, оцениваемых функциями приспособленно-

сти, и используют эволюционную и генетическую обусловленность изме-

нения последовательности битов или чисел. Таким образом эффективно

исследуется пространство возможных решений. Оптимальное решение

ищется в серии последовательных приближений аргументов с лучшими

значениями функций приспособленности, генерируемых в результате му-

тации и скрещивания хромосом.

Автор этих заметок в качестве председателя Комитета Симпозиу-

ма Computational Intelligence- Imitating Life, состоявшегося в Орландо

в 1994 г., стоял у истоков слияния этих трех научных направлений и воз-

никновения новой интегральной отрасли знаний. Он с удовольствием

приветствует «Нейронные сети, генетические алгоритмы и нечеткие сис-

темы» - новаторскую книгу на польском издательском рынке. Помимо об-

суждения базовых элементов нейронных сетей, описания нечетких сис-

тем и эволюционногенетических алгоритмов, этот труд содержит и ориги-

нальные научные результаты авторов. В книге приводятся подробности

реализации конкретных технических решений, в том числе различных

процессоров и обучаемых систем, основанных на нечеткой логике. Боль-

шое внимание уделяется вопросам практического использования ряда

пакетов прикладных программ.

Тематически книга связана с научными направлениями Всеполь-

ских конференций по нейронным сетям и их приложениям, организован-

ных профессором Л. Рутковским и Польским товариществом нейронных

сетей в 1994 и 1996 г.г.

Данная публикация под руководством профессора Л. Рутковского

чрезвычайно актуальна, ценна и уникальна. Она заполняет обширную ни-

шу на емком научнотехническом рынке Польши. Книга окажется особен-

но полезной инженерам различных специальностей, экономистам, физи-

кам, математикам и специалистам по информатике, а также студентам

Предисловие________________________________________________21

этих и смежных с ними областей знаний. Следует поздравить авторов

с большим достижением в виде этого прекрасного научного труда

Эта книга должна не только умножить признание их заслуг, но

и привлечь новые ряды энтузиастов этой захватывающей научной дис-

циплины.

Июль 1996 г.

ЯцекЖурада

член IEEE.

Университет Луисвилль, США

Предисловие к русскому изданию

Проблематика нейронных сетей, генетических алгоритмов и не-

четких систем, и в особенности комбинации этих методов - это одна из

наиболее интенсивно развивающихся в настоящее время областей ис-

следований, получившей название «Вычислительные технологии». Ее

можно считать современным ответвлением информатики (Computer

Science), связанным с методами искусственного интеллекта (Artificial

Intelligence), хотя и принципиально отличным от классического подхода,

применяемого адептами этого направления.

Дисциплина «Вычислительные технологии» исследует интеллек-

туальные методы решения различных задач и находит применение в раз-

личных областях, в том числе в промышленности, экономике, медицине

и др. Нейронные сети, генетические алгоритмы и нечеткие системы до-

полняют классические экспертные системы, которые считаются одним

из главных направлений приложения искусственного интеллекта, а также

в некоторых случаях выполняют функции этих систем путем реализации

так называемых интеллектуальных вычислительных систем. Последние

представляют собой объединение нейронных сетей, генетических алго-

ритмов и нечетких систем, взаимодействие которых позволяет решать

различные задачи, но самое важное - они становятся универсальным ин-

струментом для обработки информации. Одна и та же система может

применяться для решения различных задач, что считается несомненным

достоинством по сравнению с классическими экспертными системами,

ориентированными, как правило, на достаточно узкую проблему, напри-

мер, на медицинскую диагностику конкретного заболевания. Интеллекту-

альные вычислительные системы можно легко «перепрограммировать»

на решение другой задачи, причем роль такого программирования игра-

ет обучение. Таким образом, эти системы обладают способностью к обу-

чению, что считается главным атрибутом интеллектуальности.

Теоретические основы методов, применяемых в сфере «Вычисли-

тельные технологии», заложены исследованиями, проводимыми в об-

ласти «Soft Computing». Эта отрасль информатики занимается так назы-

ваемыми мягкими вычислениями, которые характеризуются неполнотой

данных и отсутствием точности. К ним относятся нечеткие системы, неко-

торые разделы теории вероятностей, а также нейронные сети и генетиче-

ские алгоритмы. Наиболее известной фигурой среди исследователей

этой области является профессор Л. Заде из Computer Science Division

в Беркли, который в 1965 г. опубликовал знаменитую работу, посвящен-

ную нечетким множествам (Fuzzy Sets), а в настоящее время исполняет

обязанности директора Initiative in Soft Computing (BICS). Его многочис-

ленные публикации, посвященные нечеткой логике (Fuzzy Logic) привели

к созданию нечетких систем (Fuzzy Sets), которые нашли разнообразные

практические применения, например, для управления бытовой техникой,

поездами японского метрополитена, вертолетами, производственными

процессами и т.п. Известны их реализации и в других областях, в частно-

сти, в медицине.

По тематике Soft Computing публикуются многочисленные работы;

посвященные нечетким системам, генетическим алгоритмам и нейрон-

Предисловие к русскому изданию

ным сетям, их гибридам и практическим приложениям. Проводятся раз-

личные конференции, на которых представляются новейшие результаты

исследований обсуждаемых нами методов и интеллектуальных техноло-

гий.

Книга «Нейронные сети, генетические алгоритмы и нечеткие систе-

мы», первая версия которой была выпущена Варшавским издательством

PWN в 1997 г., заняла на польском книжном рынке пустовавшую прежде

нишу описания методов, применяемых в сфере вычислительных

технологий, и их объединений. О большом интересе к представленным

в ней проблемам свидетельствует быстрая раскупаемость первого тира-

жа и последующих допечаток. Читатель держит в руках русское издание

нашей книги, в которое по сравнению с польскими версиями внесены не-

которые изменения и дополнения.

Авторы посвящают русское издание книги памяти недавно скон-

чавшегося профессора Якова Залмановича Цыпкина и выражают призна-

тельность за его огромный вклад в развитие теории адаптивных систем.

Профессор Яков Залманович Цыпкин останется для нас великим Ученым

и Человеком

Лешек Руткоеский

Председатель Польского общества

нейронных сетей

ГЛАВА 1

ВВЕДЕНИЕ

В последние годы большой интерес вызывает проблематика ней-

ронных сетей, генетических алгоритмов и нечетких систем. Эти направле-

ния относятся к научной области, определяемой в англоязычной литера-

туре термином Computational Intelligence. Взаимосвязи между нейронны-

ми сетями, генетическими алгоритмами и нечеткими системами послужи-

ли причиной того, что IEEE (Institute of Electrical and Electronics Engineers

- США) создал Всемирный Конгресс Computational Intelligence [10]. В рам-

ках этого конгресса в период с 26 июня по 2 июля 1994 г. в Орлаедо, штат

Флорида (США) были проведены три конференции:

a) IEEE International Conference on Neural Networks,

6) IEEE International Conference on Fuzzy Systems,

в) IEEE International Conference on Evolutionary Computation.

В 1995 - 1997 гг. каждая из этих конференций проводилась неза-

висимо, но в 1998 г. вновь был организован Конгресс, проведенный

на этот раз в Анкоридже на Аляске (США). На рис. 1.1. видно, что задачи

нейронных сетей, генетических алгоритмов и нечетких систем могут

рассматриваться вне связи между собой, однако их взаимозависимость

оказывается необычайно важной. В частности, генетические алгорит-

мы можно применять для подбора весов и топологии нейронной се-

ти, а также для формирования базы правил и функций принадлежности

нечеткой системы

В свою очередь, нейронные

сети позволяют выбирать соответ-

ствующие параметры для самих

генетических алгоритмов (параме-

тры скрещивания и мутации); саму

философию нейронных сетей

можно заложить в фундамент не-

четких систем, которые в результа-

те обретают способность к обуче-

нию.

Кроме того, методы теории

нечетких множеств позволяют

подбирать как упомянутые выше

параметры генетических алгорит-

мов, так и коэффициенты, опреде-

ляющие скорость обучения ней-

ронных сетей.

В Польше перечисленные

„ * * _ выше проблемы интенсивно ис-

Рис. 1.1. Взаимосвязи между нейрон- следуются во многих научных

ними сетями, генетическими апгорит- центрах. В области нейронных се-

мами и нечеткими системами. тей перВым достаточно полным

Введение

15

и очень полезным изданием считается книга профессора Р. Тадеусе-

вича [7]. В настоящее время некоторые фрагменты этой книги представ-

ляются автором также и на видеокассете [8]. В последующие годы увиде-

ли свет и другие издания: книга, подводящая итоги работы коллектива

лсд руководством профессора Ю. Корбича [3], монография профес-

сора С. Осовского [5] и работа, представляющая результаты исследова-

ний группы профессора Т. Каспшака в области клеточных нейронных се-

тей [2].

Следует также отметить факт, что некоторые монографии поль-

ских авторов известны и по достоинству оценены в мировой литературе.

В частности, можно назвать

а) по нейронным сетям - книги профессора Я. Журады [9] и про-

фессора А. Чихотского (с соавтором) [1];

б) по нечетким системам - книга профессора В. Педрыша [6];

в) по генетическим алгоритмам - книга профессора 3. Михалеви-

ча [4].

Поскольку ни одно из упомянутых прекрасных изданий не охваты-

вает одновременно все три ветви, объединяемые под названием

«вычислительные технологии», авторы настоящей работы поставили пе-

ред собой задачу раскрыть перед читателем необычайно интересные

возможности нейронных сетей, генетических алгоритмов и нечетких сис-

тем, а также их композиций.

В главе 2 представлены основные структуры одно и многослойных

нейронных сетей и алгоритмы их обучения В первой части описывается

перцептрон и системы типа Адалайн. Далее приводятся два алгоритма

обучения многослойных нейронных сетей: классический и наиболее час-

то применяемый алгоритм обратного распространения ошибки, а также

значительно более быстрый алгоритм, основанный на рекуррентном ме-

тоде наименьших квадратов.

В главе 3 обсуждаются системы, использующие нечеткую логику.

Они особенно полезны в ситуации, когда доступные знания представле-

ны в виде правил, основанных на нечетких множествах и лингвистичес-

ких переменных Системы этого типа де-факто признаны стандартом

в Японии, где они применяются в автоматических стиральных и посудо-

моечных машинах, видеокамерах и фотоаппаратах, кондиционерах и ав-

томобилях. Излагаются элементы теории нечетких множеств и нечеткого

вывода, также описывается функционирование различных нечетких про-

цессоров.

Основам реализации генетических алгоритмов посвящена глава 4.

Как известно, естественный путь развития мозга - это эволюционный

процесс, с которым связаны специфические методы проб и ошибок. Идеи

эволюционных изменений привели к созданию генетических алгоритмов,

применяемых для обучения нейронных сетей и в системах, использую-

щих нечеткую логику.

В книге представляются не только раздельные описания нейрон-

ных сетей и нечетких систем, но и (в главе 5) новейшие результаты, полу-

чаемые при их объединении. Композиции этого типа сохраняют и усили-

вают достоинства как нейронных сетей, так и нечетких систем. Они потен-

16

Глава 1. Введение

циально применимы во всех ситуациях, когда конструктор системы рас-

полагает и количественной (численные данные), и качественной (лингви-

стические правила) информацией

В конце каждой главы приводится список литературы.

Вопросы, обсуждаемые в книге, подробно иллюстрируются имита-

ционными примерами, реализованными с помощью следующих пакетов

программ:

1 . FLiNN (программа написана на кафедре Компьютерной инженерии

Политехнического университета г. Ченстохова (Польша));

2 FlexTool (GA) М2.1 (Flexible Intelligence Group) - пакет, взаимодей-

ствующий с комплексом MATLAB (The MathWorks Inc.);

3 . Evolver (Axcelis, Inc.) - пакет, взаимодействующий с программой

Excel (Microsoft Corp.);

4 BrainMaker и Genetic Training Option (California Scientific Software);

5 Fide (Aptronix, Inc.);

6 Fuzzy Logic Toolbox - прикладной пакет программ комплекса MAT-

LAB (The MathWorks, Inc.).

Выражаем признательность господам Уве фон Аммон и Марку

Скарбек-Козетульскому из фирмы Motorola, благодаря любезности кото-

рых мы получили пакет Fide

Первый опыт работы с перечисленными программными средства-

ми мы приобретали совместно со студентами четвертого курса Политех-

нического университета г. Ченстохова по специальности «Электроника и

компьютерная инженерия», которых хотелось бы поблагодарить за со-

трудничество в ходе учебных занятий. Мы также сердечно благодарим

госпожу Ренату Марчиняк и магистра инженера Артура Стажевского за

труд по подготовке рисунков и рукописи.

Особую признательность выражаем рецензентам - профессору

Юзефу Корбишу и профессору Рышарду Тадеусевичу за внимательное

ознакомление с рукописью и очень полезные замечания.

Список литературы

[1] Cichocki A., Unbehauen R., Neural Networks for Optimization and

Signal Processing, Wiley, Chichester 1993.

[2] Kacprzak T, Slot K., Sieci neuronowe komorkowe. Teoria, projek-

towanie, zastosowania, PWN, Warszawa-Lodz 1994.

(3] Korbicz J., Obuchowicz A., Ucinski D., Sztuczne sieci neuronowe,

podstawy i zastosowania, Akademicka Oficyna Wydawnicza,

Warszawa 1994.

[4] Michalewicz Z., Genetic Algorithms + Data Structures = Evolution

Programs, Springer-Verlag, Beriin 1994.

[5] Osowski S., Sieci neuronowe w ujeciu algorytmicznym, WNT,

Warszawa 1996.

[6] Pedrycz W., Fuzzy Control and Fuzzy Systems, Wiley, New York

1993.

[7] Tadeusiewicz R., Sieci neuronowe, Akademicka Oficyna

Wydawnicza, Warszawa 1993.

Список литературы 17

[8] Tadeusiewicz R., Wprowadzenie do sieci neuronowych, kaseta

wideo Polskie Towarzystwo Sieci Neuronowych, Czestochowa 1996.

[9] Zurada J. M., Introduction to Artificial Neural Systems, West

Publishing Company, Boston 1992.

[10] Zurada J. M., Marks R. J., Robinson C. J., (red.), Computational

Intelligence: Imitating Life, IEEE Press, New York 1994.

ГЛABА2

МНОГОСЛОЙНЫЕ НЕЙРОННЫЕ СЕТИ И

АЛГОРИТМЫ ИХ ОБУЧЕНИЯ

2.1. Введение

Нейронные сети можно рассматривать как современные вычисли-

тельные системы, которые преобразуют информацию по образу процес-

сов, происходящих в мозгу человека. Обрабатываемая информация име-

ет численный характер, что позволяет использовать нейронную сеть, на-

пример, в качестве модели объекта с совершенно неизвестными харак-

теристиками. Другие типовые приложения нейронных сетей охватывают

задачи распознавания, классификации, анализа и сжатия образов.

Проблематика нейронных сетей в девяностых годах XX века на-

шла отражение в сотнях монографий, среди которых можно упомянуть

изданные в Польше работы [10, 11,13,17, 24]1 и некоторые заграничные

публикации [3, 5, 7, 8,15, 21, 28]. Также следует упомянуть о прекрасных

обзорных статьях, которые стали катализатором дальнейших исследова-

ний как в Польше (Р. Тадеушевич [22]), так и за границей (Р. Липпманн

[14]).

Свыше 80 % всех приложений нейронных сетей относится к так на-

зываемым многослойным сетям без обратных связей. В них сигнал пере-

сылается в направлении от входного слоя через скрытые слои (если они

имеются) к выходному слою. Сети именно такого типа будут рассматри-

ваться в последующих главах книги в контексте генетических алгоритмов

и нечетких систем. Поэтому в настоящей главе мы обсудим в первую оче-

редь базовые элементы многослойных нейронных сетей - персептрон

и системы типа Адалайн (с линейным и нелинейным выходом), после че-

го определим два алгоритма обучения этих сетей: алгоритм обратного

распространения ошибки и рекуррентный алгоритм метода наименьших

квадратов.

Хотелось бы подчеркнуть, что в нашей монографии представляет-

ся достаточно узкий, однако весьма важный с прикладной точки зрения

фрагмент необычайно обширной области знаний, которая получила на-

звание «искусственные нейронные сети». Приглашаем читателя к более

углубленному изучению литературных источников, перечень которых

приводится в конце главы

2.2. Нейрон и его модели

Базовый элемент нервной системы (см. [23]) - это нервная клетка,

называемая нейроном. В нейроне можно выделить тело клетки, называ-

емое сомой, а также исходящие из него два вида отростков: а) по кото-

рым в нейрон поступает информация - дендриты и б) по которому ней-

Переработанная версия монографии проф. С. Осовского [17] под назва-

нием «Нейронные сети для обработки информации» издана в 2002 г. на

русском языке издательством «Финансы и статистика». - Прим, перев.

2.2. Нейрон и его модели

рон передает информацию - аксон. Каждый нейрон имеет только один

выходной отросток, по которому он может передавать импульс несколь-

ким другим нейронам.

Одиночный нейрон принимает возбуждения от огромного количе-

ства нейронов (их число может достигать тысячи). Считается, что мозг че-

ловека состоит из порядка 1011 нейронов, которые имеют между собой

примерно 1015 соединений. Каждый нейрон передает возбуждение дру-

гим нейронам через нервные стыки, называемые синапсами, при этом

процесс передачи сигналов имеет сложную электрохимическую природу

Синапсы играют роль репитеров информации, в результате функциони-

рования которых возбуждение может усиливаться или ослабляться. Как

следствие, к нейрону приходят сигналы, одна часть из которых оказыва-

ет возбуждающее, а вторая - тормозящее воздействие. Нейрон суммиру-

ет возбуждающие и тормозящие импульсы. Если их алгебраическая сум-

ма превышает некоторое пороговое значение, то сигнал с выхода нейро-

на пересылается посредством аксона к другим нейронам. На рис. 2.1.

представлена упрощенная модель нейрона.

Рассмотрим модель нейрона, связанную с первыми попытками

формализовать описание функционирования нервной клетки. Введем

следующие обозначения:

щ....- входные сигналы данного нейрона, приходящие от дру-

гих нейронов;

iv,,.... - синаптические веса;

у- выходной сигнал нейрона;

v пороговое значение.

Формула, описывающая функционирование нейрона, имеет вид

Рис. 2.1. Упрощенная модель нейрона и его соединения с соседним нейроном:

1 - тело клетки, 2 - аксон, 3 - дендриты, 4 - синапсы.

Глава 2. Многослойные нейронные сети и алгоритмы их обучения

Модель (2.1) может быть представлена в виде

у=^и/,-ц^ (2.2)

где

{1 при х > 0 ,

О при х < 0

а также w0 = v, и0 = 1.

Формула (2.2) описывает модель нейрона, представленную на

рис. 2.2. Эта модель была предложена в 1943 г. МакКаллоком и Питт-

сом [16]. В качестве функции Сможет приниматься не только единич-

ная функция (2.3), но и другие пороговые функции вида

{1 при х > 0 ,

-1 прих<0. <2-4>

или

11 при X > 1 ,

-1 при х < -1, (2.5)

х при |х|<1.

На начальной фазе моделирования биологических нейронных

сетей применялись пороговые функции (2.3), (2.4) и (2.5). В настоя-

щее время чаще всего используется сигмоидальная функция, опре-

деляемая выражением

ад=777^>0- (Z6)

Рис. 2.2. Модель нейрона.

2.2. Нейрон и его модели

Отметим, что при /3->~ характеристика (2.6) стремится к поро-

говой униполярной функции (2.3). В качестве альтернативы применя-

ется функция гиперболического тангенса

„ ( ах \ 1-е а*

f(x>=,hbd 77

(2.7)

В этом случае характеристика (2.7) стремится к пороговой би-

полярной функции (2.4) при Примеры функции f в модели (2.2)

показаны на рис. 2.3.

2.3. Персептрон

Модель МакКаллока-Питтса стала отправной точкой для пост-

роения простейшей однонаправленной нейронной сети, названной

персептроном. Такую сеть предложил и исследовал Розенблатт [18]

в конце пятидесятых - начале шестидесятых годов XX века. На

рис. 2.4 представлена структура персептрона, иногда называемого

Рис. 2.3. Примеры функции f.

22

Глава 2. Многослойные нейронные сети и алгоритмы их обучения

простейшим персептроном. В качестве функции f в модели МакКал-

лока-Питтса (2.2) применялась биполярная функция активации (2.4).

Сигнал х на выходе линейной части персептрона задается вы-

ражением

N N

X = X W'u' ~ v ~ X Wiui (2.8)

i=0

где w0 = v, u0 = -1.

Задача персептрона заключается в классификации вектора и =

.....uN]T в смысле отнесения его к одному из двух классов, обознача-

емых символами Ц и Ц. Персептрон относит вектор и к классу Lv если

выходной сигнал у принимает значение 1, и к классу /.2, если выходной

сигнал у принимает значение - 1. После этого персептрон разделяет

/V-мерное пространство входных векторов и на два полупространства,

разделяемые (Д/-7)-мерной гиперплоскостью, задаваемой уравнением

N N

WjU, - V = X wiui = °

2.3. Персептрон

23

Гиперплоскость (2.9) называется решающей границей {decision

boundary). Если N = 2, то решающая граница - это прямая линия, задава-

емая уравнением

+ w2u2 - v = 0. (2.10)

Точка {щ ,и2), лежащая над этой прямой (рис. 2.5), относится к клас-

су Ц, тогда как точка {щ,и2), лежащая под этой прямой, относится к клас-

су L2. Точки, лежащие на границе решения, можно произвольно отнести

и к классу Lf и к классу L2.

Для дальнейших рассуждений допустим, что веса wt, / = 0, 1.N

в уравнении гиперплоскости (2.9) неизвестны, тогда как на вход персеп-

трона последовательно подаются так называемые обучающие сигналы

и{п), п = 1,2.где и{п) = [о/л)..иЛп)]Т.

Неизвестные значения весов будут определяться в процессе обу-

чения персептрона. Такой подход получил название «обучение с учите-

лем» или «обучение под надзором». Роль «учителя» заключается в кор-

ректном отнесении сигналов u(n) к классам L1 или /_2, несмотря на неиз-

вестность весов уравнения решающей границы (2.9). По завершении

процесса обучения персептрон должен корректно классифицировать по-

ступающие на его вход сигналы, в том числе и те, которые отсутствовали

в обучающей последовательности u{n), п = 1, 2..Кроме того, примем,

что множества векторов u{n), п = 1, 2, ..., для которых выходной персеп-

трона принимает соответственно значения 1 и -1, линейно отделены, т.е.

лежат в двух различных полупространствах, разделенных гиперплоскос-

тью (2.9). Другими словами, допускается разделение обучающей пос-

ледовательности {и(л)} на две последовательности {щ{п)} и {и2{п)} так,

что {щ{п)} е L, и {u2(n)} е L2.

В n-й момент времени сигнал на выходе линейной части персеп-

трона определяется выражением

Рис. 2.5. Решающая граница для N = 2.

24

Глава 2. Многослойные нейронные сети и алгоритмы их обучения

х(п)= = wT(n)u(n), (2.11)

|=о

где

u(n) = [-1, иу(п), и2(п).....................ut/n)]T, (2.12)

w(n) = [v(n), w^n), w2(n)..w^n)]T. (2.13)

Обучение персептрона заключается в рекуррентной коррекции

вектора весов w(n) согласно формулам

, +n=J‘v<n)> если ivr(n)u(n)> 0 и u(n)e Lj ,

W'n ' I w(n), если wT(n)u(n)<0 и u(n)e L2,

= Г w(n)-Tju(n), если wT(n)u(n)>0 и u(n)e L2 ,

W n [ w{n)+r]u(n), если wT(n)(n)< 0 и u(n)e ,

где параметр rj при 0 < ij < 1 - шаг коррекции, тогда как начальные зна-

чения компонент вектора весов устанавливаются равными нулю, т.е.

w(0) = 0 (2.16)

Зависимости (2.14) и (2.15) можно представить в более сжатом ви-

де. Для этого определим так называемый эталонный (заданный) сигнал

d(n) в форме

{+1, если и(п)е Lf ,

-1, если и(п)е L2 .

(2-17)

Кроме того, отметим, что выходной сигнал персептрона может быть опи-

сан выражением

у(п) = sgn(wr(n)u(n)). (2.18)

С учетом введенных обозначений рекурсии (2.14) и (2.15) прини-

мают вид

w(n + 1) = w(n) + [d(n) - y(n)] U(n) (2.19)

Разность d(n) - y(n) можно интерпретировать как погрешность

между эталонным (заданным) сигналом cf(n) и фактическим выходным

сигналом у(п).

Сходимость алгоритма (2.19) исследовал Розенблатт в оригиналь-

ной работе [18], а также другие авторы в более поздних публикациях (на-

пример, [5, 7, 8]). С учетом принятого выше условия линейной сепара-

бельности входных сигналов алгоритм (2.19) сходится, т.е.

iv(n0) = w(n0 + 1) = iv(n0 + 2) = .. (2.20)

По завершении обучения решающая граница персептрона опреде-

ляется выражением

N

=0, (2.21)

/=о

2.4. Системы типа Адалайн

25

а персептрон корректно классифицирует как сигналы, которые принадле-

жат к обучающей выборке {и(п)}, так и не входящие в это множество, но

выполняющие условие линейной сепарабельности. Напомним, что усло-

вию линейной сепарабельности не отвечает логическая функция XOR,

заданная таблицей 2.1.

Из рис. 2.6 следует, что не существует прямой, которая отделила

бы точки со значениями функции XOR, равными - 1, от точек со значени-

ями, равными 1. В этом случае роль примерной границы играет эллипс,

и поэтому алгоритм (2.18) не был бы сходящимся. Проблему XOR можно

разрешить с помощью двухслойного персептрона. Эта. проблема деталь-

но исследована в работах [13] и [24].

2.4. Системы типа Адалайн

Системы типа Адалайн (Adaptive Linear Neuron - адаптивный ли-

нейный нейрон) были предложены в 1960 г. Видроу и Хоффом [25]. Вид-

роу и Лер [26] описали целое семейство систем типа Адалайн. В настоя-

Таблица 2.1. Логическая функция XOR

,71 I d = ХОВ(щ,о2)

+1 +1 -1

-1 +1 *1

-1 -1 -1

Рис. 2.6. Иллюстрация проблемы XOR.

26 Глава 2. Многослойные нейронные сети и алгоритмы их обучения

щей главе перед детальным обсуждением систем типа Адалайн (пп. 2.4.2

и 2.4.3) рассмотрим модель так называемого линейного взвешенного сум-

матора

2.4.1. Линейный взвешенный сумматор

На рис. 2.7. представлена структура линейного взвешенного сум-

матора (linear combiner^. Его выход образуется сигналом у(п), который

представляет собой линейную комбинацию всех входов и-Дп), и2(п), ....

Uf/n), п = 1, 2,... . Введем обозначение

u(n) = [щ(л), и2(п).и,/п)]Т. (2.22)

Конкретные компоненты вектора и(п) умножаются на компоненты

вектора весов

w=lw1,w2.....w,JT (2.23)

В результате выходной сигнал линейного взвешенного сумматора

описывается формулой

м

у(п) = =wTu(n). (2.24)

/<=1

Выход линейного взвешенного сумматора у(п) будет использовать-

ся в качестве реализации некоторого сигнала cf(n), называемого эталон-

ным или заданным сигналом. В результате сравнения реализации у(п)

с сигналом d(n) получаем погрешность реализации

£ (п) ~ с((п) — у(п). (2.25)

Рис. 2.7. Линейный взвешенный сумматор.

У(п)

Здесь и далее для удобства читателей и следуя польскому изданию в

скобках иногда указывается английское название термина. - Прим, перев.

2.4. Системы типа Адалайн

27

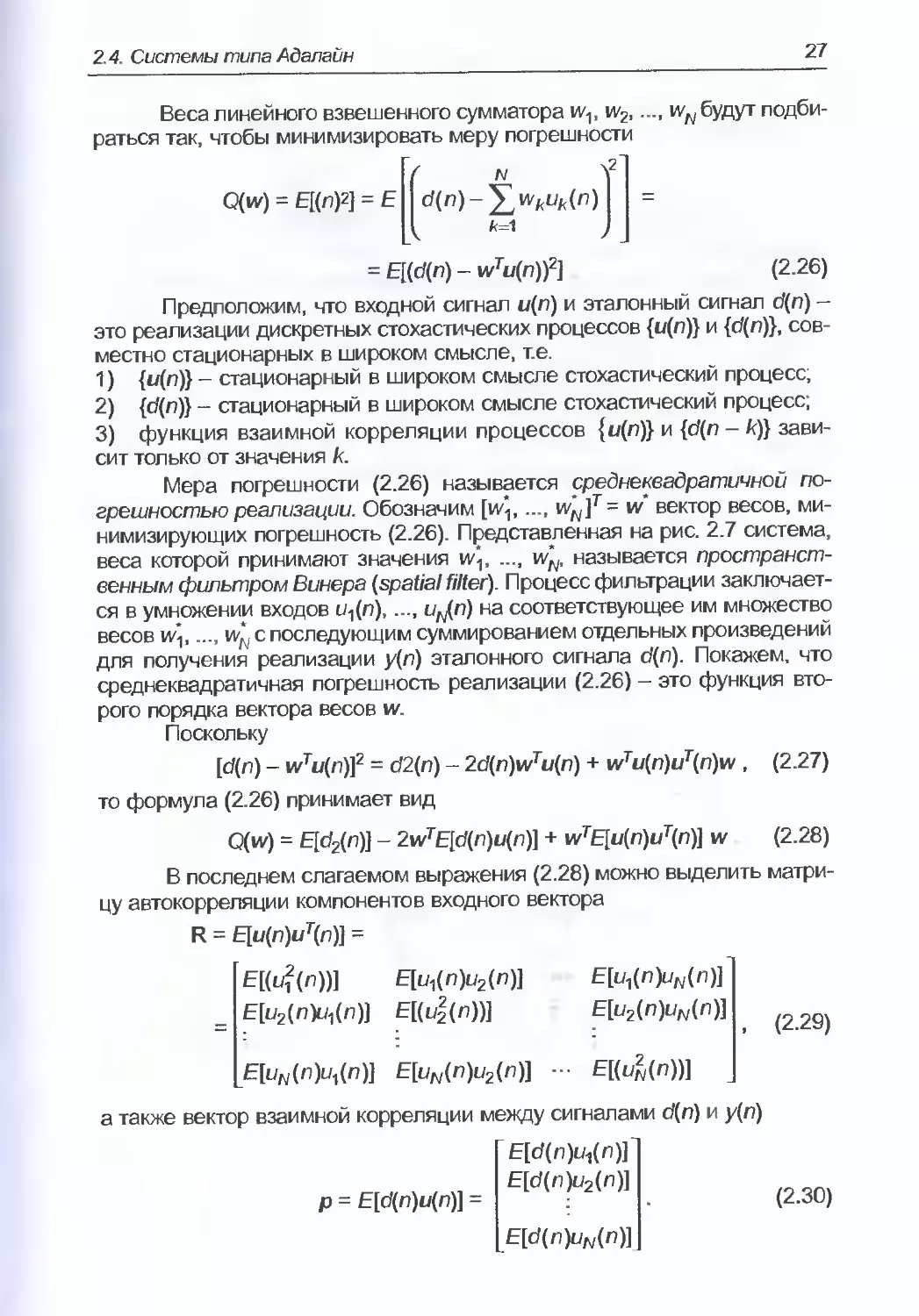

Веса линейного взвешенного сумматора w1, w2.wN будут подби-

раться так, чтобы минимизировать меру погрешности

N fl

Q(w) = EI(n)2) = E|p(n)-^i‘W(fi)| =

I fc=1 7

= E[(d(n)-wTu(n)f) (2.26)

Предположим, что входной сигнал u(n) и эталонный сигнал d(n) -

это реализации дискретных стохастических процессов {и(п)} и {с/(п)}, сов-

местно стационарных в широком смысле, т.е.

1) - стационарный в широком смысле стохастический процесс;

2) {cf(n)} - стационарный в широком смысле стохастический процесс;

3) функция взаимной корреляции процессов {«(«)} и {d(n - к)} зави-

сит только от значения к.

Мера погрешности (2.26) называется среднеквадратичной по-

грешностью реализации. Обозначим [и/;,..., = w‘ вектор весов, ми-

нимизирующих погрешность (2.26). Представленная на рис. 2.7 система,

веса которой принимают значения w\, .... w^, называется пространст-

венным фильтром Винера (spatial filter). Процесс фильтрации заключает-

ся в умножении входов щ(п),..., иг/п) на соответствующее им множество

весов w\,.... w*N с последующим суммированием отдельных произведений

для получения реализации у(л) эталонного сигнала d(n). Покажем, что

среднеквадратичная погрешность реализации (2.26) - это функция вто-

рого порядка вектора весов w.

Поскольку

[d(n) - wTu(n)]2 = d2(n) - 2d(n)wTu(n) + wTu(n)uT(n)w , (2.27)

то формула (2.26) принимает вид

Q(iv) = Е[с72(л)] - 2wTE[d(n)u(n)] + wTE[u(n)uT(n)] w (2.28)

В последнем слагаемом выражения (2.28) можно выделить матри-

цу автокорреляции компонентов входного вектора

R = Е[и(п)иТ(п)] =

E[(ui(n))] E[ui(n)u2(n)]

Е[и2(п)и^п)] Е[(и2(п))]

E[u^(n)uN(n)]

E[u2(n)uN(n)]

(2.29)

E[uN(n)u}(n)] E[uN(n)u2(n)] - E[(ul(n))]

а также вектор взаимной корреляции между сигналами d(n) и у(л)

р = E[d(n)u(n)] =

~ Е[д(п)и,(п)Г

E[d(n)u2(n)]

E[d(n)uN(n)]

(2.30)

28

Глава 2. Многослойные нейронные сети и алгоритмы их обучения

С использованием обозначений (2.29) и (2.30) среднеквадратич-

ная погрешность реализации (2.28) может быть записана в виде

Q(iv) = E[d2(n)] - 2wTp + ivrRiv. (2.31)

Из выражения (2.31) следует, что среднеквадратичная погреш-

ность реализации Q(iv) - это функция второго порядка вектора весов w

С геометрической точки зрения Q(w) представляется гиперпараболои-

дом, имеющим единственный глобальный экстремум Q*. Этот гиперпара-

болоид называется поверхностью среднеквадратичной погрешности

Рис. 2.8 представляет фрагмент типовой поверхности среднеквадратич-

ной погрешности для N - 2 (в этом случае это параболоид).

Поверхность среднеквадратичной погрешности, описываемая

уравнением (2.31), имеет единственный глобальный экстремум Q*, дости-

гаемый при оптимальных значениях весов w\.w*N. Вычисление опти-

мальных значений весов сводится к определению вектора градиента

V функции Q(iv) и приравниванию полученного результата к нулю:

...Д| =2R»'-2₽=(|. <2з2>

где 0 есть Л/-мерный нулевой вектор. Допустим, что гессиан

v2=af2.=2R (2.33)

дмг

это положительно определенная матрица. В этом случае вектор весов w"

Q(w„w2)

Рис. 2.8. Поверхность среднеквадратичной погрешности.

2.4. Системы типа Адалайн

29

минимизирует среднеквадратичную погрешность реализации (2.31). Из

уравнения (2.32) следует, что для этого вектора справедливо равенство

Rw' = р . (2.34)

Равенство (2.34) называется нормальным уравнением. Если det R

0, то его решением оказывается вектор

w* = R 1р (2.35)

При w - w погрешность принимает минимальное значение, обо-

значаемое Q* и равное

Q(iv') = Q* = E[d2(n)] “ 2iv*rp + iv*r Riv*. (2.36)

Если подставить равенство (2.34) в выражение (2.36), то получим

формулу для расчета минимальной среднеквадратичной погрешности

реализации

Q* = E[d2(n)] - w*rp . (2.37)

Для нахождения оптимального вектора весов w‘, удовлетворяю-

щего нормальному уравнению (2.34), требуется инвертировать матрицу

автокорреляции R. Вместо этого можно использовать метод наискорей-

шего спуска (см., например, [2,6]), который широко применяется в теории

оптимизации. В этом методе предусматривается итеративный расчет по-

следовательных приближений оптимального вектора ш'. Обозначим iv(n)

приближение, рассчитанное на л-й итерации

w(n)= [^(л), ..., wjn)]r. (2.38)

Очередные коррекции компонентов вектора весов w(n) должны

производиться в направлении, противоположном знаку компонентов век-

тора градиента

dQ(iv(n)) _[~dQ(iv(n)) dQ(w(n))]

й(и<(л)) [ Эи^л) dwN(n) J

Алгоритм наискорейшего спуска можно представить в виде

w(n + 1) = w(n) -j»? (2-40)

При подстановке формулы (2.32) в зависимость (2.40) получаем

рекурсию

w(n + 1) = iv(n) + [р - Rw(n)l, (2.41)

где константа ij > 0 определяет величину шага коррекции.

Можно показать (см., например, [8, 19]), что алгоритм наиско-

рейшего спуска (2.41) сходится, т.е.

lim w(n) = w*, (2.42)

n->~

если шаг коррекции z; лежит в пределах

где Zmax - это наибольшее собственное значение матрицы автокорреля-

ции R.

30 Глава 2. Многослойные нейронные сети и алгоритмы их обучения

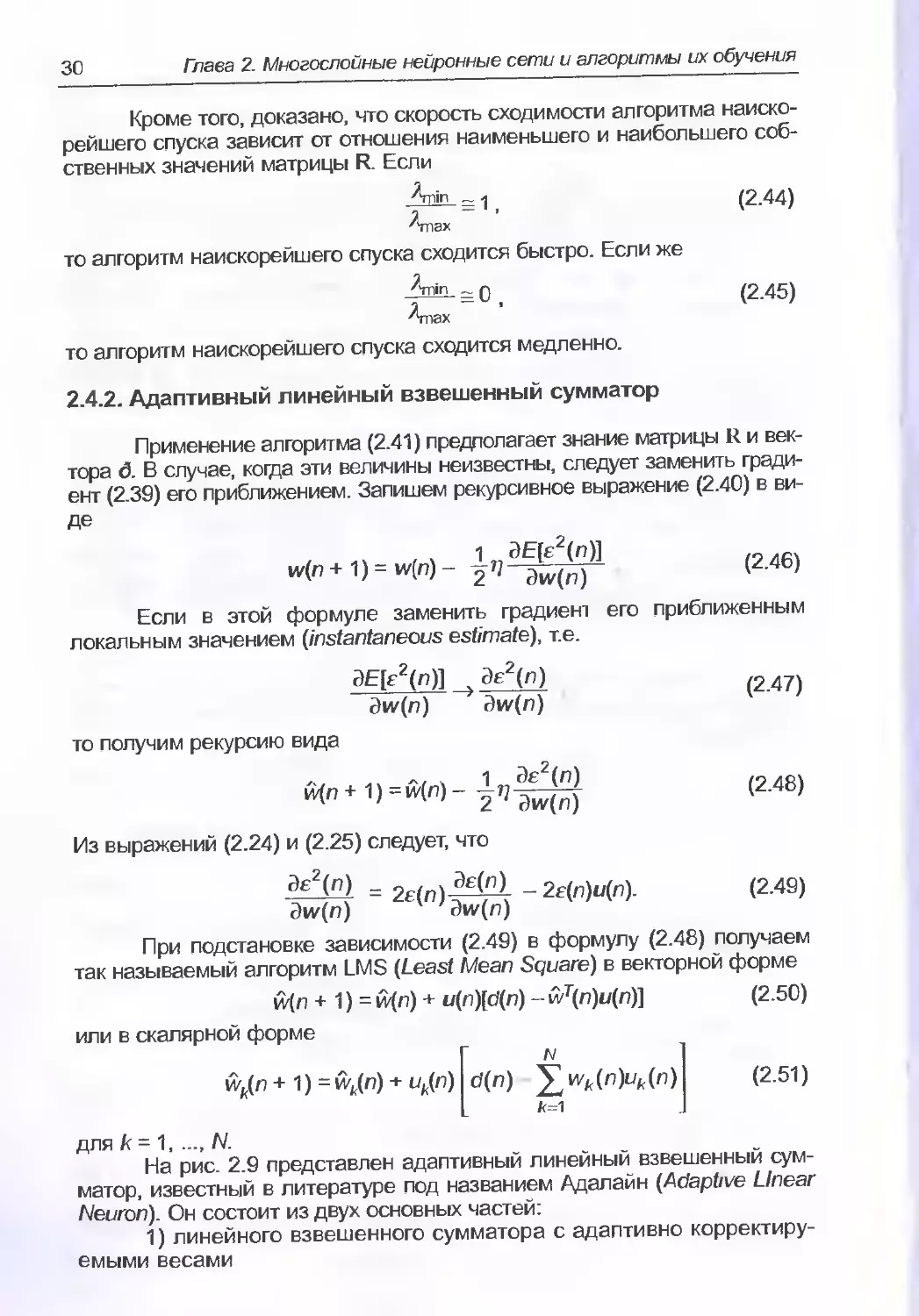

Кроме того, доказано, что скорость сходимости алгоритма наиско-

рейшего спуска зависит от отношения наименьшего и наибольшего соб-

ственных значений матрицы R. Если

-^*- = 1, (2.44)

Лпах

то алгоритм наискорейшего спуска сходится быстро. Если же

= 0, (2.45)

Алах

то алгоритм наискорейшего спуска сходится медленно.

2.4.2. Адаптивный линейный взвешенный сумматор

Применение алгоритма (2.41) предполагает знание матрицы R и век-

тора д. В случае, когда эти величины неизвестны, следует заменить гради-

ент (2.39) его приближением. Запишем рекурсивное выражение (2.40) в ви-

де

(2Л6)

Если в этой формуле заменить градиент его приближенным

локальным значением (instantaneous estimate), т.е.

ЭЕ[£2(п)] Э£2(л) 24 }

dw(n) ЙИГ(п) 1 7

то получим рекурсию вида

(2.46)

Из выражений (2.24) и (2.25) следует, что

X) = <2-49)

При подстановке зависимости (2.49) в формулу (2.48) получаем

так называемый алгоритм LMS (Least Mean Square) в векторной форме

w(n + 1) = vv(n) + u(n)[d(n) - wT(n)u(n)] (2.50)

или в скалярной форме

ык(п + 1) = wk(n) + ик(п) р(п) У wfc(nH(n)j (2.51)

для к = 1...N.

На рис. 2.9 представлен адаптивный линейный взвешенный сум-

матор, известный в литературе под названием Адалайн (Adaptive Linear

Neuron). Он состоит из двух основных частей:

1) линейного взвешенного сумматора с адаптивно корректиру-

емыми весами

2.4 Системы типа Адалайн

31

Рис. 2.9. Адаптивный линейный взвешенный сумматор.

й'Лп)...й^п),

2) подсистемы, предназначенной для адаптивной коррекции этих

весов и реализующей алгоритм LMS.

Параметр Т) в алгоритме (2.50) подбирается так (см. [27]), чтобы

выполнялось условие

TrR w

£Е[(^(п))2]

(2.52)

где TrR обозначает след матрицы R.

2.4.3. Адаптивный линейный взвешенный сумматор

с сигмоидой на выходе

Выходной сигнал адаптивного линейного сумматора с сигмоидой

на выходе (рис. 2.10) можно описать выражением

у(л) = Г £^(п)иДп)

где функция f определяется формулой (2.6). Погрешность реализации

(2.25) равна

32

Глава 2. Многослойные нейронные сети и алгоритмы их обучения

Рис. 2.10. Адаптивный линейный взвешенный сумматор с сигмоидой на выходе.

£(n) = d(n)-^£wHm(n/| (2.54)

Для коррекции весов w^k), к = 1.N применим алгоритм LMS

в рекурсивной форме (2.48). В этом случае очевидно равенство

3^(п) = 2е(п)Э£(п1 ,)w(n) 4 ;Sw(n) ' (2.55)

а также E)£(n)_ 3f(x(n))_ Эх(п) dw(n)~ dw(n) н v ,,3w(n) (2-56)

где

x(n)= ^wk(n)uk(n) =wT(n)u(n). (2-57)

Поскольку

=u(n)’ (2.58)

то l^nj =-f'Wn))u(n). (2-59)

2.5. Алгоритм обратного распространения ошибки

При подстановке равенств (2.55) и (2.59) в рекурсивное выражение

(2.48) получим следующий алгоритм адаптивной коррекции весов

w[n + 1) =w[n) , (2.60)

либо в скалярной форме

w^n + 1) = wk (n) + (n)f (х(л))иДл), (2.61)

для k = 1....N. Если p = 1, го функция (2.6) отвечает условию

Г(х) = f(x)(1 - f(x)). (2.62)

Поэтому алгоритм (2.60) можно записать в форме

wk(n + 1) = wk (n) + (n)f(x(n))(1 - f(x(n)))uk(n) (2.63)

для k= 1,.... N, где погрешность e(n) определяется выражением (2.54).

Алгоритмы (2.60) и (2.63) положены в основу метода обратного

распространения ошибки, который подробно описывается в следую-

щем разделе.

2.5. Алгоритм обратного распространения ошибки

Обсудим алгоритм обратного распространения ошибки [20], кото-

рый позволяет обучать многогослойные нейронные сети. Этот алгоритм

считается наиболее известным и чаще всего применяемым в искусствен-

ных нейронных сетях.

На рис. 2.11. представлена многослойная нейронная сеть, со-

стоящая из L слоев.

В каждом слое расположено Nk элементов, к = 1.L, обозначае-

мых ADf, i = Л,.... Nk. Элементы ADf будем называть нейронами, причем

каждый из них может быть системой типа Адалайн с нелинейной функци-

ей (сигмоидой либо гиперболическим тангенсом) на выходе. Обсуждае-

Рис. 2.11. Многослойная нейронная сеть.

Гпава 2. Многослойные нейронные сети и алгоритмы их обучения

мая нейронная сеть имеет No входов, на которые подаются сигналы щ(л),

..., uNo(n), записываемые в векторной форме как

u = [^i(n)..%(п)Г, л =1,2,... (2.64)

Выходной сигнал /-го нейрона в к-м слое обозначается уЯ(л),

i= .... Nk, к= 1...L.

На рис. 2.12 показана детальная структура ьго нейрона в к-ы слое.

Нейрон ADf имеет Nk входов, образующих вектор

x<fc,(n)= [х^(п).................(л)]т, (2.65)

причем х№(п) = +1 для / = 0 и к = 1.L Обратим внимание на факт, что

входной сигнал нейрона AD^ связан с выходным сигналом (к - 1) слоя

следующим образом:

)ц(л) для к = 1,

у,(/< 1) для к = 2....L, (2.66)

+ 1 для i = 0,k = \...,L

На рис. 2.12 w^(n) обозначает вес связи /-го нейрона, / = 1.Nk, распо-

ложенного в к-м слое, которая соединяет этот нейрон с /-м входным сиг-

налом x№(n),j =0, 1...NkV Вектор весов нейрона ADf обозначим

м'/к,(п) = Но)(п) (л/, к = 1...........L. i= 1,.... Nk. (2.67)

Выходной сигнал нейрона ADf в л-й момент времени, л = 1, 2, ...

определяется как

y}k)(n) = f(sfk)(n)), (2.68)

причем

/v„,

sjk>(n)=:^iv^>(n)xj-'<)(n). (2.69)

j=o

Рис. 2.12. Структура нейрона АО* .

2.5. Алгоритм обратного распространения ошибки 35

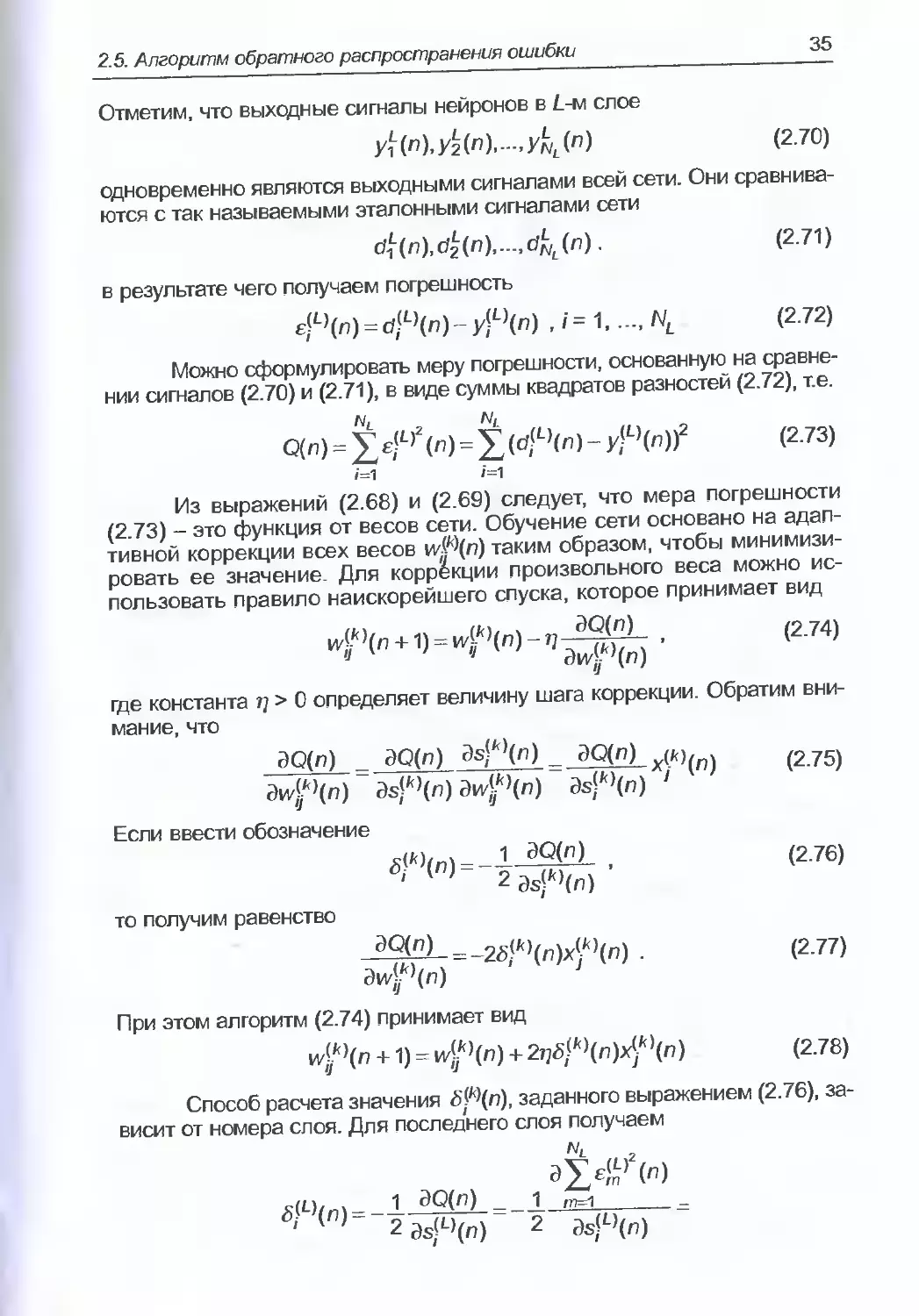

Отметим, что выходные сигналы нейронов в Е-м слое

У1(п),У2(п).-,У^(п) (2.70)

одновременно являются выходными сигналами всей сети. Они сравнива-

ются с так называемыми эталонными сигналами сети

....................................cl^(n). (2.71)

в результате чего получаем погрешность

£(L>(n) = ^L)(n)- yV-\n) ,i=t,...,NL (2.72)

Можно сформулировать меру погрешности, основанную на сравне-

нии сигналов (2.70) и (2.71), в виде суммы квадратов разностей (2.72), т.е.

О(л) - £^,2(л) = £(#’( л) - У^’(п))2 (2.73)

Из выражений (2.68) и (2.69) следует, что мера погрешности

(2.73) - это функция от весов сети. Обучение сети основано на адап-

тивной коррекции всех весов viffXri) таким образом, чтобы минимизи-

ровать ее значение. Для коррекции произвольного веса можно ис-

пользовать правило наискорейшего спуска, которое принимает вид

^(п +1) = ^>(п) - . (2 74)

1 ‘ дм/^Чп)

где константа Т] > 0 определяет величину шага коррекции. Обратим вни-

мание, что

ЭО(л) _ ЭО(п) Э#>(п) _ dQ(n) (275)

dwf4n) ds]k4n)dw^4n) ds?4n) '

Если ввести обозначение

gfM(n) = _1_3Q(nL , (2.76)

' г&уЧп)

то получим равенство

-^)- = _25/*>(п)х^(п) . (2.77)

Эи/^(л)

При этом алгоритм (2.74) принимает вид

и^’(п +1) = и^’(п) + 2^k4n)^4n) (2.78)

Способ расчета значения 5^(п), заданного выражением (2.76), за-

висит от номера слоя. Для последнего слоя получаем

1 ЭО(л) _ 1 _____

' ( ' 2 3s(t)(n) 2 ds(D(n)

36 Глава 2. Многослойные нейронные сети и алгоритмы их обучения

= 1 = 1 d(d*L)(n)-y(L)(n))2 =

2 3s?L,(n) 2 3sJL,(n)

= £/L,(n)MjT7 £lL)(n)f'(slL)(n)) (279)

ds} '(n)

Для произвольного слоя к* L получаем

х(Ю/л1 = 1 dQ(n) = __1 ЭО(п) aS^+1>(n) =

' 29s(D(n) 2 2^ds(^)(n) ds(K)(n)

= хе1’^)^1^)^^^)) =

m=1

= f'^k\n)) f^n^n) (2.80)

Определим погрешность в к-ы (не последнем) слое для /-го нейро-

на в виде

£/k,(n) = ХЧ*+1,(п)и^+1)(п) (2.81)

т=1

Если подставить выражение (2.81) в формулу (2.80), то получим

^ik\n) E^\n)f'(s^k\n)) (2.82)

В результате алгоритм обратного распространения ошибки можно

записать в виде

N*-i i = f(sjfc,(n)), s,('(,(n)= X/w('t,(n)x<'t>(n) , J=o (2.83)

d|L)(n) - y-L)(n) для к L ,

£?'',(п) = £d^+1’(n>v^+1)(n) для к =\...,L-1, (2.84)

^k\n) £jkXn)f'(sjkXn)) , (2.85)

wf\n +1) = ^’(n) + 2j]5/k,(n)xj,<,(n). (2.86)

Название алгоритма связано со способом расчета погрешностей

в конкретных слоях. Вначале рассчитываются погрешности в последнем

2.6. Применение рекуррентного метода наименьших квадратов

слое (на основе выходных и эталонных сигналов), далее - в предпослед-

нем и так вплоть до первого слоя. Начальные значения весов, образую-

щих сеть, выбираются случайным образом и, как правило, устанавлива-

ются близкими к нулю. Шаг коррекции т] чаще всего принимает большие

значения (близкие единице) на начальных этапах процесса обучения, но

впоследствии его следует уменьшать по мере того как веса приближают-

ся к некоторым заранее определенным значениям. В литературе, посвя-

щенной нейронным сетям (например, в [3]), рекомендуются различные

модификации алгоритма обратного распространения ошибки. Одна из

наиболее известных модификаций заключается во введении в рекурсию

(2.86) дополнительного члена, называемого моментом:

+1) wW{n) + 2i]Eik\n)f'{sjk\n))x{k\n) +

+ a[w£ >(n) - wW{n - 1)] , (2.87)

в котором параметр осе (0,1). Экспериментальные исследования показы-

вают [24], что введение момента ускоряет сходимость алгоритма обрат-

ного распространения ошибки

2.6. Применение рекуррентного метода наименьших

квадратов для обучения нейронных сетей

Обучение сети с использованием изложенного в п. 2.5 алгоритм

обратного распространения ошибки требует большого количества итера-

ций. Поэтому в литературных источниках приводятся сведения о различ-

ных попытках создания более быстрых алгоритмов (см., например, [12])

В работе [1] для обучения нейронных сетей применялся рекур-

рентный метод наименьших квадратов {recursive least squares - RLS).

В качестве меры погрешности использовалось выражение

Q(n) = gZ'1-,££(L,2(0 =

л н, г

= ^^£[djt,«)~/r(x(L> ^^^(п))]2 , (2.88)

t=i j=i

где Л - так называемый коэффициент забывания {forgetting factor), зна-

чение которого выбирается из интервала [0,1]. Обратим внимание на то,

что степень влияния членов выражения (2.88) на его значение возраста-

ет с увеличением номера члена. В ходе дальнейших рассуждений будем

использовать обозначения, введенные в п. 2.5, с учетом особенностей,

показанных на рис. 2.13, т.е.

£<*)(/) = dfk)(t) - y,<fc)(0 , (2.89)

а также

bjk\t) = f'l{d^\t)), (2.90)

где f-обратимая функция, t = 1,.... п, i = 1,.... Nk, k=U .... L.

38

Глава 2 Многослойные нейронные сети и алгоритмы их обучения

Ы fi 1~

Рис. 2.13. Структура нейрона, применяемого для реализации алгоритма RLS.

Если рассчитать градиент меры погрешности и приравнять его

к нулю, то получим уравнение

dwlk\n) dwfXn) 7

(2-91)

= -2^ Л"-4^^<О(() = 0

При использовании зависимостей (2.68) и (2.69) уравнение (2.91)

принимает вид

у Г-'У Эу^)(0 V ^>(0 dyjTfr) ю

= У r~fyl9ypL 1)(0У ^wW\t) =

£ £dw}k>(n)£ ds<LXt) JP j( )

= У У —L 1)(0Е(1-~1)(0 = у ЛЛ“'У дУр){Г* £w(t) = О , (2 92)

£^кЧп)р () й J

где

i ’<'>= <2Е°»

2.6. Применение рекуррентного метода наименьших квадратов

Выражение (2.93) задает способ последовательного определения

погрешностей в каждом слое, начиная с последнего. При дальнейших

преобразованиях получаем последовательность равенств вида

У лл~'У э4*}(0 e(lf)(Q=

4кЧо=

^ds^(n)dw^(n)

= (2-94)

y(ft)=[yr.-,y<J’]r.

При использовании аппроксимации

f(bW(t)) = f(s?*>(0) + - s}k>(t)) (2.95)

получаем нормальное уравнение

^Z’-ff2(s)'<,(0)[fc!'<,(0-x('<,7(0iv1<'<,(n)]x(/<,r(0 = 0 , (2.96)

г=1

векторная форма которого имеет вид

^k\n)^\n)w\k\n) , (2.97)

где

R^’tn) - ^Zn~ff2(sf'<’(())x(*)(()x<,<>r (() , (2.98)

г=1

r}k\n) = ^ntf'2^k\t))b^k\t)x{k\t) (2.99)

Уравнение (2.97) можно решить рекуррентным способом, без ин-

вертирования матрицы RW(n). Это требует использования алгоритма

RLS (например, [19]), согласно которому адаптивная коррекция всех ве-

сов w№ производится согласно правилам

Id-L,(n)-y,-L,(n) для/с L ,

Xr^^W^^nJe^n) дляк 1..........д-!, (2-100)

40

Глава 2. Многослойные нейронные сети и алгоритмы их обучения

' Л + f'2(slk4n))x™ (пррЧп - 1)х(кЧп)

Р}к\п) = Л“1[1 - Г^Чп^Чп)^(n)F}k4n -1) . (2.102)

w{k4n) = wfk4n -1) + д^Ч^У^Чп) (2.103)

где/=1.......Nk,

Начальные значения в алгоритме RLS, как правило, устанавлива-

ются следующим образом:

Р<к>(0) = 51, £» 0 , (2.104)

iv('<,(0) = 0. (2.105)

Начальные значения весов wik\0) нейронной сети могут также вы-

бираться случайным способом из заранее установленного диапазона.

Пример 2.1

Сравним функционирование алгоритма обратного распростране-

ния ошибки (2.86), модифицированного алгоритма (2.87) и алгоритма

RLS (2.103). Для этого двухслойную нейронную сеть с сигмоидальными

функциями будем использовать для имитации логической системы XOR

и декодера 4-2-4. Процесс имитации должен длиться достаточно долго

для того, чтобы значение погрешности Q(n) стало меньше заданного по-

рога у, те.

NL

Q(n) = ^(d$L4n)-у^Чп))2 <Т. (2-106)

где Nl = 1 в случае логической системы XOR и NL = 4 в случае декодера

4-2-4. На рисунках, иллюстрирующих результаты моделирования, под

эпохой (ер) понимается количество итераций, равное числу различных

пар векторов входных и эталонных сигналов (один цикл предъявления

обучающей выборки). В обоих примерах каждая эпоха состоит из четы-

рех итераций обучающего алгоритма.

а) Логическая система XOR. Нейронная сеть имеет 2 входа, 2 ней-

рона в скрытом слое и 1 выход. Заданный порог / равен 0.02. В отдель-

ные эпохи выделены следующие пары векторов входных и эталонных

сигналов:

(0,0; 0), (0,1; 1), (1,0; 1), (1,1; 0).

Результаты моделирования представлены на рис. 2.14.

б) Декодер 4-2-4 Нейронная сеть имеет 4 входа, 2 нейрона

в скрытом слое и 4 нейрона в выходном слое. Заданный порог у ра-

вен 0,02. В отдельные эпохи выделены следующие пары векторов

входных и эталонных сигналов:

2.6. Применение рекуррентного метода наименьших квадратов 41

Рис. 2.14. Результаты моделирования логической системы XOR: а) алгоритм

обратного распространения ошибки; б) модифицированный алгоритм обратного

распространения ошибки (с учетом момента); в) алгоритм RLS.

Глава 2. Многослойные нейронные сети и алгоритмы их обучения

Рис. 2.15. Результаты моделирования декодера 4-2-4: а) алгоритм обратного

распространения ошибки; б) модифицированный алгоритм обратного

распространения ошибки (с учетом момента); в) алгоритм RLS.

Список литературы

43

(1,0,0,0; 1,0,0,0) (0,1,0,0; 0,1,0,0),

(0,0,1,0; 0,0,1,0) (0,0,0,1; 0,0,0,1).

Результаты моделирования представлены на рис. 2.15

Легко заметить, что модифицированный (с учетом момента)

алгоритм обратного распространения ошибки работает в несколько раз

быстрее традиционного алгоритма, тоща как применение алгоритма RLS

позволяет увеличить эту скорость еще на порядок

Список литературы

[1] Bilski J., Szybkie algorytmy uczenia sieci neuronowych, AGH,

Krakow, 1995, praca doktorska.

[2] Chong E. К R, Zak S. H., An Introduction to Optimization, Wiley,

1996.

[3] Cichocki A., Unbehauen R., Neural Networks for Optimization and

Signal Processing, Wiley, 1993.

[4] Dayhoff J., Neural Network Architectures, Van Nostrand Reinhold,

New York 1990.

[5] Fausett L., Fundamentals of Neural Networks, Prentice Hall, 1994.

[6] Findeisen W., Szymanowski W., Wierzbicki A., Teona i metody

obliczeniowe optymalizacji, PWN, Warszawa 1977.

[7] Hassoun M. H., Fundamentals of Artificial Neural Networks, MIT

Press, 1995.

[8] Haykin S., Neural Networks: A Comprehensive Foundation,

Macmillan Publishing Company, 1994.

[9] HechtNielson R., Neurocomputing, Addison-Wesley, New York 1990.

[10] Hertz J., Krogh A., Palmer R. G„ Wstep do teorii obliczen neu-

ronowych, WNT, Warszawa 1993.

[11] Kacprzak T., SlotK.. Sieci neuronowe komorkowe, PWN, Warszawa-

Lodz 1994.

[12] Karayiannis N. B., Venetsanopoulos A. N., Artificial Neural Networks,

Kluwer Academic Publishers, 1993.

[13] Korbicz J., Obuchowicz A., Ucinski D., Sztuczne sieci neuronowe.

Podstawy i zastosowania, Akademicka Oficyna Wydawnicza,

Warszawa 1994.

[14] Lippmann R. E, An Introduction to Computing with Neural Nets,

IEEE, ASSP Magazine, April 1987, s. 4-22.

[15] Maren A. J., Harston C.T., Pap R. M., Handbook of Neural

Computing Applications, Academic Press, San Diego, California

1990.

[16] Me Culloch W. S., A Logical Calculus of The Ideas Immanent In

Nervous Activity, Biulletin of Mathematical Biophysics, 1943, nr 5,

s. 115-133.

44 Глава 2. Многослойные нейронные сети и алгоритмы их обучения

[17] Osowski S., Sieci neuronowe w ujeciu algorytmicznym, WNT,

Warszawa 1996.

[18] Rosenblatt R, On the Convergence of Reinforcement Procedures in

Simple Perceptrons, Cornell Aeronautical Laboratory Report

VG-1196-G-4, Buffalo, NY, Feb. 1960.

[19] Rutkowski L., Filtry adaptacyjne i adaptacyjne przetwarzanie syg-

nalow, WNT, Warszawa 1994.

[20] Rumelhart D. E., Hinton G. E., Williams R. J., Learning Internal

Representations by Error Propagation, In Parallel Distributed

Procesing, t. 1, rozdz. 8, Rumelhart D. E. and McClelland J. L„ Eds.,

Cambridge, MA, M.LT. Press, 1986.

[21] Simpson R K., Artificial Neural Systems: Foundations, Paradigms,

Applications and Implementations, Pergamon Press, New York

1990.

[22] Tadeusiewicz R., Sieci neuronowe — przewodnik problemowy,

Elektrotechnika, 1991, t. 10, z. 2, s. 125-167.

[23] Tadeusiewicz R., Problemy biocybemetyki, PWN, Warszawa 1991.

[24] Tadeusiewicz R., Sieci neuronowe, Akademicka Oficyna

Wydawnicza, Warszawa 1993.

[25] Widrow B., Hoff M. E. Jr., Adaptive switching circuits, Western Conf.

Rec., IRE, 1960, cz. 4, s. 94-104.

[26] Widrow B., Lehr M. A., 30 Years of Adaptive Neural Networks:

Perceptron, Madeline and Backpropagation, Proc, of the IEEE, 1990,

t. 78, nr 9, S. 1415—1442..

[27] Widrow B., Stearns S., Adaptive Signal Processing, Prentice Hall,

Englewood Cliffs (N.J.), 1985.

[28] Zurada J. M., Introduction to Artificial Neural Systems, West

Publishing Company, 1992.

ГЛАВАЗ

НЕЧЕТКИЕ МНОЖЕСТВА И НЕЧЕТКИЙ ВЫВОД

3.1. Введение

В 1965 г. в журнале «Information and Control» была опубликована

известная работа Л. Заде [34] под названием Fuzzy sets. Это название пе-

реведено на русский язык как нечеткие множества. Побудительным мо-

тивом представления Л. Заде идеи и теории нечетких множеств стала не-

обходимость описания таких явлений и понятий, которые имеют

многозначный и неточный характер. Известные до этого математические

методы, использовавшие классическую теорию множеств и двузначную

логику, не позволяли решать проблемы этого типа. Вопросы, связанные с

нечеткими множествами и их приложениями, освещаются в различных

книгах и монографиях как на польском [5,15], так и на английском языках

[2, 4, 9, 16, 20, 29. 33, 35].

В настоящей главе базовые понятия и определения теории нечет-

ких множеств будут представлены в виде, удобном для не обладающего

специальной математической подготовкой читателя (пл. 3.2 3.7). Далее

мы обсудим проблемы нечеткого вывода, связанного с принятием реше-

ний на основе нечетких условий (п. 3.8). Последующие пункты касаются

проблематики построения нечетких алгоритмов (п. 3.9) и проектирования

базы нечетких правил на основе численных данных (п. 3.10). При изложе-

нии материала будут использоваться следующие обозначения:

1) а л b= min (а, б),

Р| а, = min (аъ а2,..., ап),

/=1

2) a v b = max (а, б),

Ua< = max (а-!, а2,.... ап)

3.2. Основные понятия и определения теории нечетких

множеств

При помощи нечетких множеств можно формально определить не-

точные и многозначные понятия, такие как «высокая температура», «мо-

лодой человек», «средний рост» либо «большой город». Перед формули-

рованием определения нечеткого множества необходимо задать так

называемую область рассуждений (universe of discourse). В случае неод-

нозначного понятия «много денег» большой будет признаваться одна

сумма, если мы ограничимся диапазоном [0, 1000 руб] и совсем другая -

в диапазоне [0, 1000000 руб]. Область рассуждений, называемая в даль-

нейшем пространством или множеством, будет чаще всего обозначать-

ся символом X. Необходимо помнить, что X - четкое множество.

46

Глава 3. Нечеткие множества и нечеткий вывод

Определение 3.1

Нечетким множеством А в некотором (непустом) пространстве X.

что обозначается как А с X. назывется множество пар

Л = {(х,дд(х));хе X} , (3.1)

ще

дд:Х—>[0,1] (3.2)

- функция принадлежности нечеткого множества А. Эта функция припи-

сывает каждому элементу х е X степень его принадлежности к нечеткому

множеству А, при этом можно выделить три случая

1) дд(х) - 1 означает полную принадлежность элемента х к нечет-

кому множеству А, т.е. х е А;

2) цД(х) = 0 означает отсутствие принадлежности элемента х к не-

четкому множеству А, т.е. х ё А;

3) 0 < дд(х) < 1 означает частичную принадлежность элемента х

к нечеткому множеству А.

В литературе применяется символьное описание нечетких мно-

жеств. Если X - это пространство с конечным количеством элементов,

т.е. X = {х4_хл}, то нечеткое множество А с X записывается в виде

А । Дд(*г) , , Мд(хп) у Дд(х,) (33)

Xi х2 £ х,-

Приведенная запись имеет символьный характер. Знак «—» не оз-

начает деления, а означает приписывание конкретным элементам хь ...,

хп степеней принадлежности дЛ(х4)..дд(хл). Другими словами, запись

Дд(х,) /=1 п (3.4)

означает пару

(Х|,дЛ(х/)),/= 1 п. (3.5)

Точно также знак «+» в выражении (3.3) не означает операцию сло-

жения, а интерпретируется как множественное суммирование элементов

(3.5). Следует отметить, что подобным образом можно записывать и чет-

кие множества. Например, множество школьных оценок можно символи-

чески представить как

D = 2 + 3 + 4 + 5, (3.6)

что равнозначно записи

D = {2, 3, 4, 5} (3.7)

Если X - это пространство с бесконечным количеством элементов,

то нечеткое множество А с X символически записывается в виде

3.2. Основные понятия и определения теории нечетких множеств

47

д (l^ldx. (3.8)

х Х

Пример 3.1

Допустим, что X = N - множество натуральных чисел. Определим

понятие множества натуральных чисел, «близких числу 7». Это можно

сделать определением следующего нечеткого множества А с X

д=Р!2 + ад Q8 1 08 Д5 Q2 (зд)

456789 10

Пример 3.2

Если X - R, где R - множество действительных чисел, то множест-

во действительных чисел, «близких числу 7», можно определить функци-

ей принадлежности вида

(310)

Поэтому нечеткое множество действительных чисел, «близких

числу 7», описывается выражением

л = |[1 + (х-7)Г. dx (311)

Замечание 3.1

Нечеткие множества натуральных или действительных чисел,

«близких числу 7», можно записать различными способами. Например,

функцию принадлежности (3.10) можно заменить выражением

Рис. 3.1. Иллюстрация к примеру 3.2: функции принадлежности нечеткого множества

действительных чисел, «близких числу 7».

48

Гпава 3. Нечеткие множества и нечеткий вывод

при 4<х<10,

в противном случае

(3-12)

На рис. 3.1 а и 3.1 б представлены две функции принадлежности

нечеткого множества А действительных чисел, «близких числу 7».

Пример 3.3

Формализуем неточное определение «подходящая температура

для купания в Балтийском море». Зададим область рассуждений в виде

множества X = [15°,.... 25°]. Отдыхающий I, лучше всего чувствующий се-

бя при температуре 21°, определил бы для себя нечеткое множество

4=0J + Q3 + 0£ + №+£^ + J_ + £9 + № + 075 + 07

16 17 18 19 20 + 21+ 22 + 23 24 25 1 * ' '

Отдыхающий II, предпочитающий температуру 20°, предложил бы

другое определение этого множества:

В = £1 + ££ + °-9 1 0.9 0.85 0,8 0,75 0,7 .

“ 15 + 16 + 17 + 18 + 19 + 20 + 21 + 22 + 23 + 24 + 25

С помощью нечетких множеств А и В мы формализовали неточное

определение понятия «подходящая температура для купания в Балтий-

ском море». В некоторых приложениях используются стандартные фор-

мы функций принадлежности. Конкретизируем эти функции и рассмотрим

их графические интерпретации.

1. Функция принадлежности класса s (рис. 3.2) определяется как

s(x; а, Ь, с) =

0 для х < а ,

2ГХ Для а<х<ь,

{с-а)

12(^с^а) ДЛЯ Ь~х~с'

1 для х > с ,

(3.15)

где b = (а + с)/2. Функция принадлежности, относящаяся к этому классу,

имеет графическое представление (рис. 3.2), напоминающее букву «э»,

причем ее форма зависит от подбора параметров а, b и с. В точке х = b =

=(а + с)/2 функция принадлежности класса s принимает значение,

равное 0,5.

2. Функция принадлежности класса я (рис. 3.3) определяется че-

рез функцию принадлежности класса s:

I s(x; с-b, с-Ь12, с) длях<с,

я(х,б,с)-| 1-S(x; с, c + fc/2, c + b) длях>с. (3-1€)

3.2. Основные понятия о определения теории нечетких множеств

49

Рис. 3.3. Функция принадлежности класса л.

Функция принадлежности класса л принимает нулевые значения

длях>с + Ьих<с-Ь. В точкахх = с + Ы2 ее значение равно 0,5.

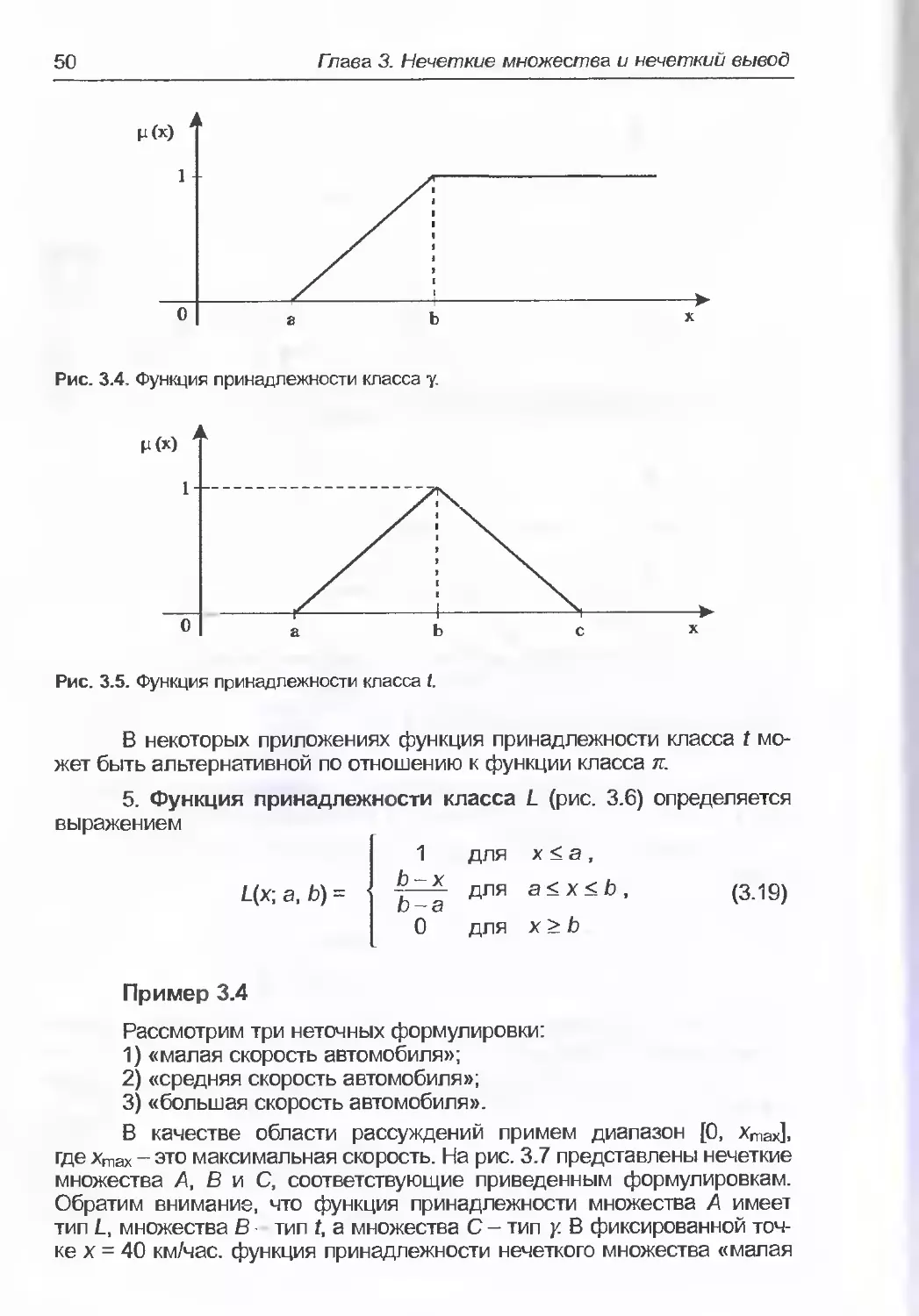

3. Функция принадлежности класса у (рис. 3.4) задается выра-

жением

(0 для х < а ,

fzf для а<х<Ь, (3.17)

1 для х > b .

Читатель с легкостью заметит аналогию между формами функций

принадлежности классов s и у.

в виде

4. Функция принадлежности класса t (рис. 3.5) определяется

0 для х < а ,

*~а для а < х < b ,

и — в

С ~ * ДЛЯ Ь < X < с ,

C-D

0 для X > с .

(3.18)

50

Глава 3. Нечеткие множества и нечеткий вывод

Рис. 3.4. Функция принадлежности класса у.

Р(Х)

Рис. 3.5. Функция принадлежности класса t.

В некоторых приложениях функция принадлежности класса t мо-

жет быть альтернативной по отношению к функции класса я.

5. Функция принадлежности класса L (рис. 3.6) определяется

выражением

11 для х < а,

для а<х<Ь, (3.19)

0 для х > b

Пример 3.4

Рассмотрим три неточных формулировки:

1) «малая скорость автомобиля»;

2) «средняя скорость автомобиля»;

3) «большая скорость автомобиля».

В качестве области рассуждений примем диапазон [0, хтах],

где Хтах - это максимальная скорость. На рис. 3.7 представлены нечеткие

множества А, В и С, соответствующие приведенным формулировкам.

Обратим внимание, что функция принадлежности множества А имеет

тип L, множества В тип t, а множества С - тип у. В фиксированной точ-

ке х = 40 км/час. функция принадлежности нечеткого множества «малая

3.2. Основные понятия и определения теории нечетких множеств 51

скорость автомобиля» принимает значение 0,5, т.е. дд(40) = 0,5. Такое же

значение принимает функция принадлежности нечеткого множества

«средняя скорость автомобиля», т.е. дв(40) = 0,5, тогда как дс (40) = 0.

Пример 3.5

На рис. 3.8 показана функция принадлежности нечеткого множест-

ва «большие деньги». Это функция класса s, причем X = [0,100000 руб],

Рис. 3.6. Функция принадлежности класса L.

Рис. 3.7. Иллюстрация к примеру 3.4; функции принадлежности нечетких множеств

«малая» (Дд(х)), «средняя» (дв(х)). «большая» (дс (х)) скорость автомобиля.

Рис. 3.8. Иллюстрация к примеру 3.5: Функция принадлежности нечеткого множества

«большие деньги».

52

Гпава 3. Нечеткие множества и нечеткий вывод

а = 1000 руб, с = 10000 руб. Следовательно, суммы, превышающие

10000 руб, можно совершенно определенно считать «большими», по-

скольку значения функции принадлежности при этом становятся равны-

ми 1. Суммы, меньшие чем 1000 руб, не относятся к «большим», так

как соответствующие им значения функции принадлежности равны 0.

Конечно, такое определение нечеткого множества «большие деньги»

имеет субъективный характер. Читатель может иметь собственное пред-

ставление о неоднозначном понятии «большие деньги» Это представ-

ление будет отражаться иными значениями параметров а и с функции

класса s.

Определение 3.2

Множество элементов пространства X, для которых дд(х) > 0, на-

зывается носителем нечеткого множества А и обозначается supp A (sup-

port). Формальная его запись имеет вид

А = {хе Х;дДх)>0}. (3.20)

Определение 3.3

Высота нечеткого множества А обозначается h(A) и определяется

как

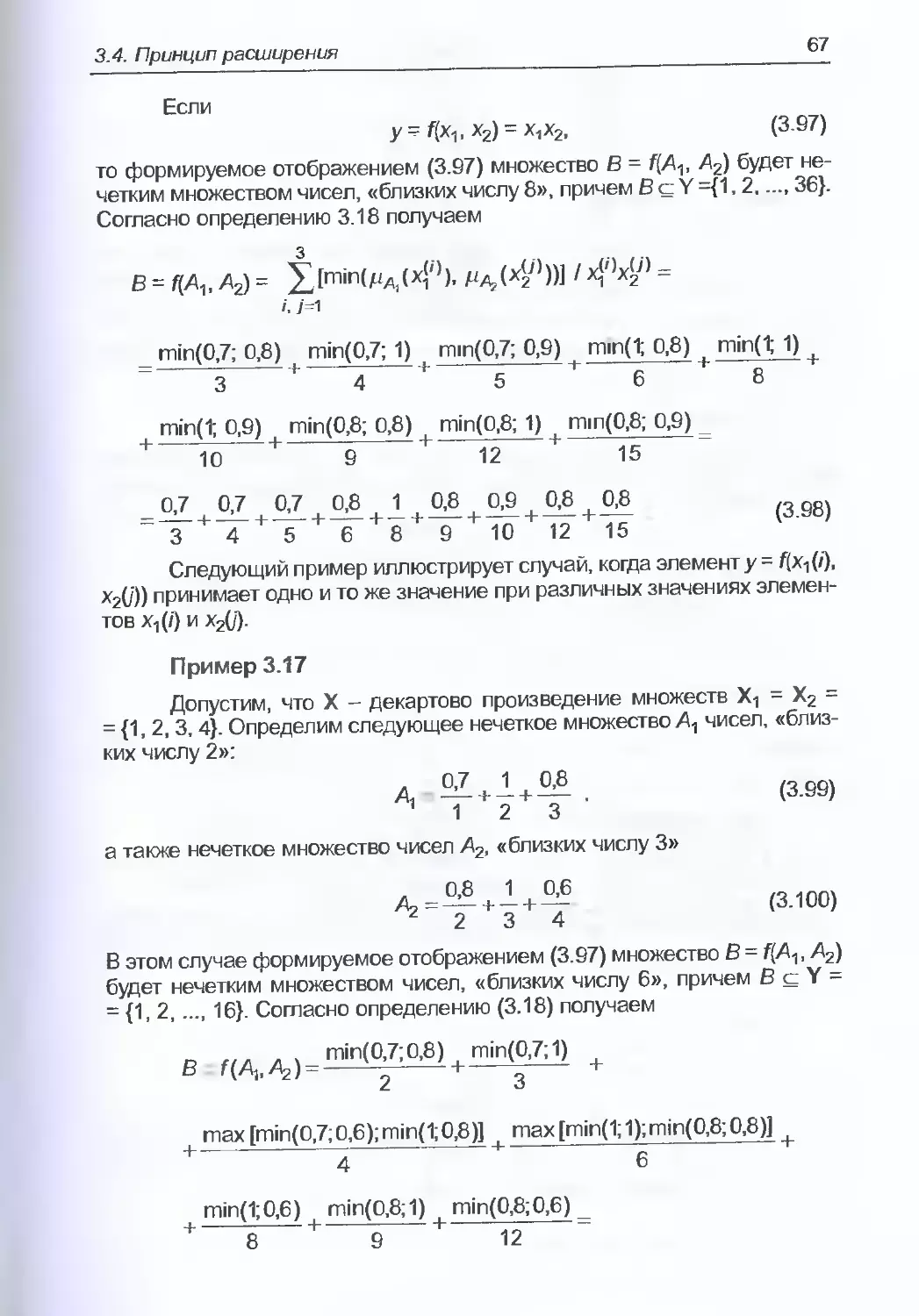

h(A) тахдд(х) (3.21)