Автор: Круглов В.В. Борисов В.В.

Теги: компьютерные технологии эргономика нейронные сети машинное обучение

ISBN: 5-93517-031-0

Год: 2002

Текст

НИН

2-е издание

Москва

2002

ББК 30.17

К 84

УДК 681.322

Круглов В.В., Борисов В. В.

К84 Искусственные нейронные сети. Теория и практика. -

2-е изд., стереотип. - М.: Горячая линия-Телеком, 2002. -

382 с: ил.

ISBN 5-93517-031-0.

Книга посвящена одному из современных направлений в

области информатики и вычислительной техники - нейрокомпьютерным

технологиям. Достоинством книги является то, что в ней рассмотрены

не только вопросы теории искусственных нейронных сетей, но

и большое внимание уделено современным программным оболочкам-

имитаторам нейронных сетей, а также решению с их помощью

практических задач распознавания образов, кластеризации,

прогнозирования, оптимизации, построения и использования нейросетевых

экспертных систем. Книга содержит обширный справочный материал.

Для научных и инженерно-технических работников в области

информатики и вычислительной техники, занимающихся созданием

и использованием интеллектуальных систем, а также аспирантов и

студентов разных специальностей в области компьютерных технологий.

ББК 30.17

Адрес издательства в Интернет radios@cityline.ru.

Научное издание

Круглов Владимир Васильевич

Борисов Вадим Владимирович

ИСКУССТВЕННЫЕ НЕЙРОННЫЕ СЕТИ. ТЕОРИЯ И ПРАКТИКА

Печатается в авторской редакции с оригинал-макета, подготовленного авторами

ЛР № 071825 от 16 марта 1999 г

ИД № 05619 от 16 августа 2001 г

Подписано в печать 20 12 2001 Формат 60x88 1/16 Печать офсетная

Бумага газетная Печ л 24,0 Тираж 3000 Заказ 441

Издательский дом «ГРААЛЬ»

141200, г Пушкино, Московской обл , ул Лесная, д 5

Отпечатано в Производственно-издательском комбинате ВИНИТИ.

140010 г Люберцы, Московской обл , Октябрьский пр-т, 403 Тел 554-21-86

ISBN 5-93517-031-0 © Круглов В В., Борисов В.В , 2002

© Оформление издательства

«Горячая линия-Телеком», 2002

Введение

Искусственные нейронные сети (ИНС) строятся по

принципам организации и функционирования их биологических аналогов.

Они способны решать широкий круг задач распознавания образов,

идентификации, прогнозирования, оптимизации, управления

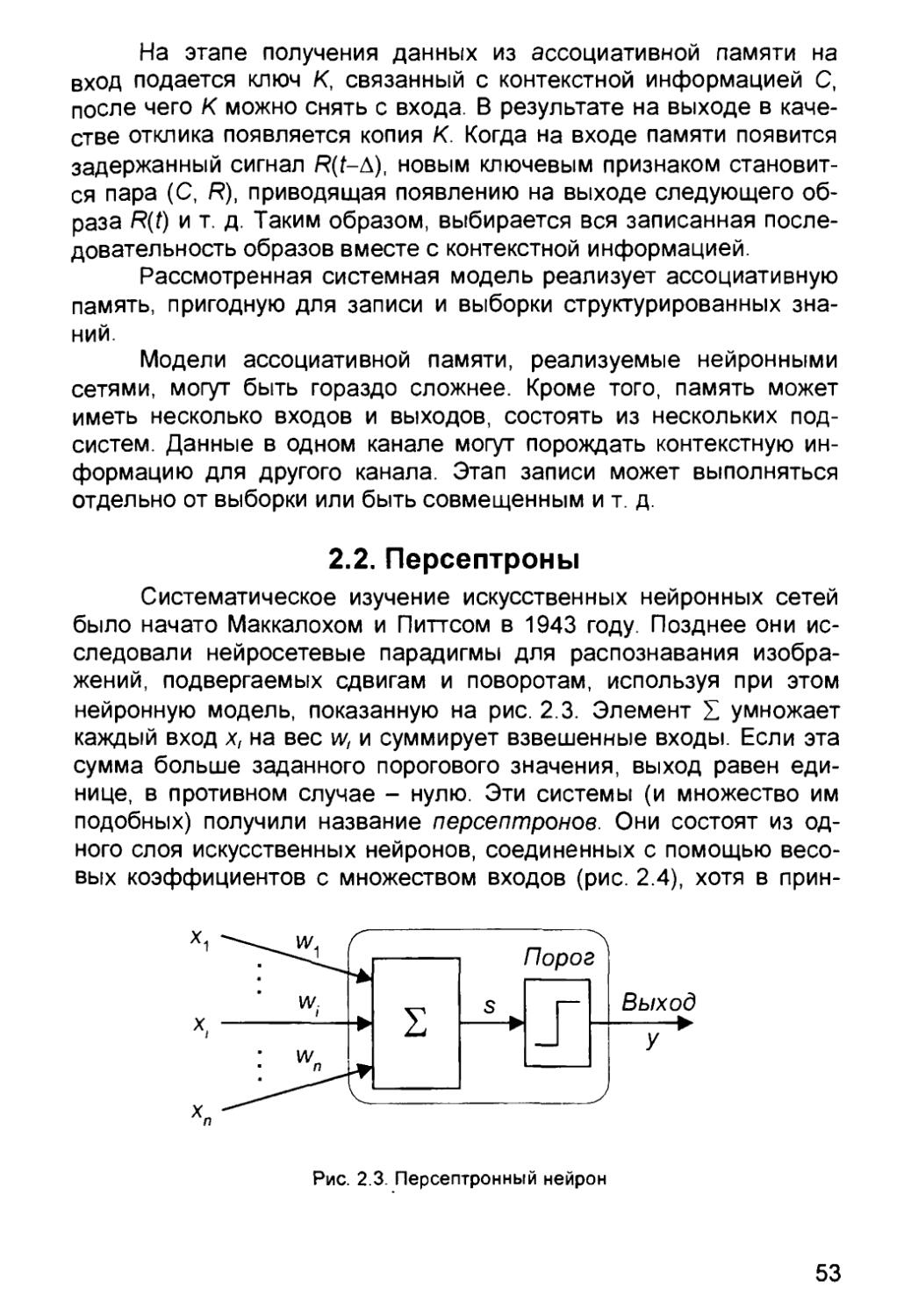

сложными объектами. Дальнейшее повышение производительности

компьютеров все в большой мере связывают с ИНС, в частности, с

нейрокомпьютерами (НК), основу которых составляет

искусственная нейронная сеть.

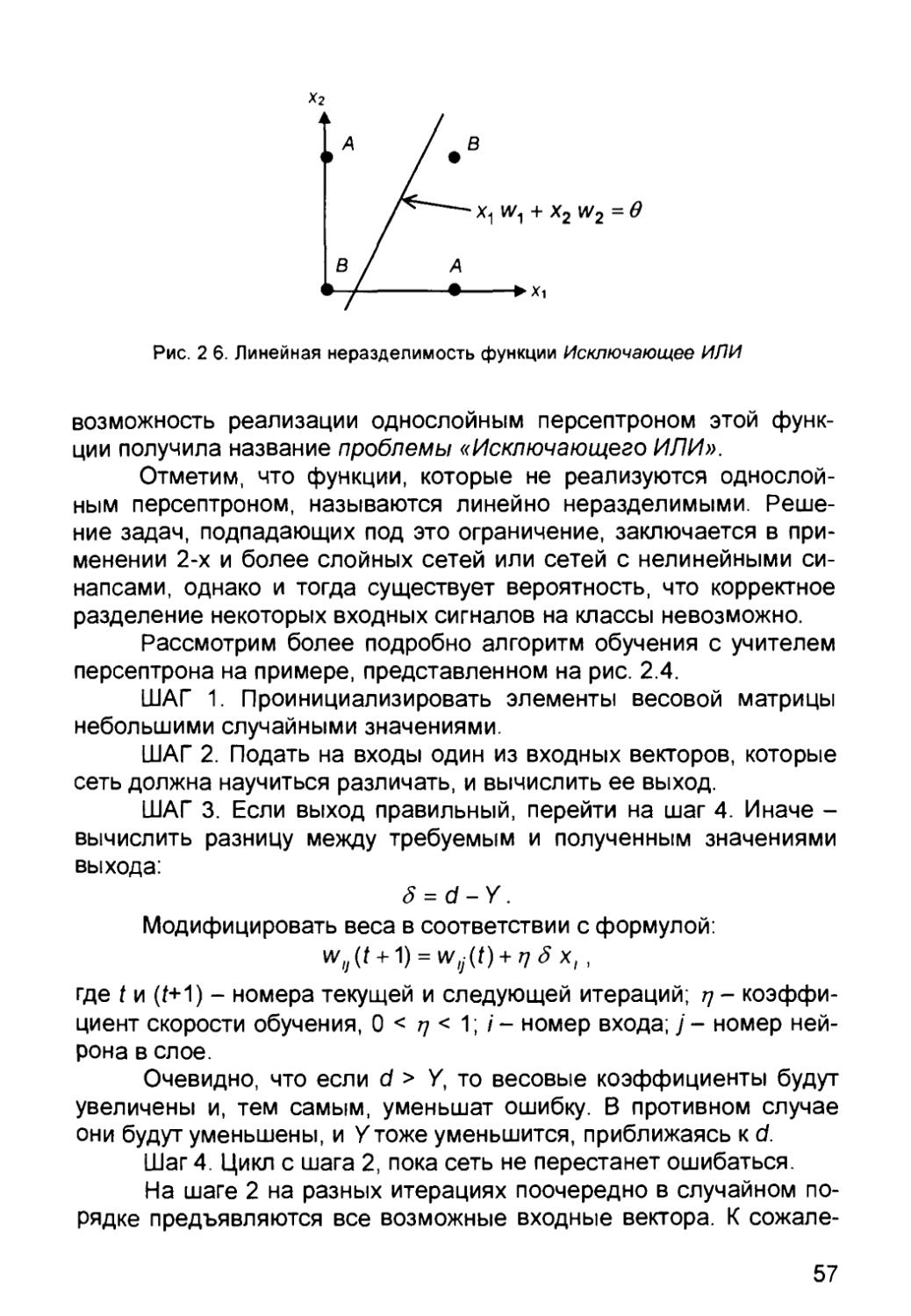

Термин «нейронные сети» сформировался к середине 50-х

годов XX века. Основные результаты в этой области связаны с

именами У. Маккалоха, Д Хебба, Ф. Розенблатта, М. Минского,

Дж. Хопфилда. Приведем краткую историческую справку.

1943 г. У. Маккалох (W. McCulloch) и У. Питтс (W. Pitts)

предложили модель нейрона и сформулировали основные положения

теории функционирования головного мозга.

1949 г. Д. Хебб (D. Hebb) высказал идеи о характере

соединений нейронов мозга и их взаимодействии (клеточные ансамбли,

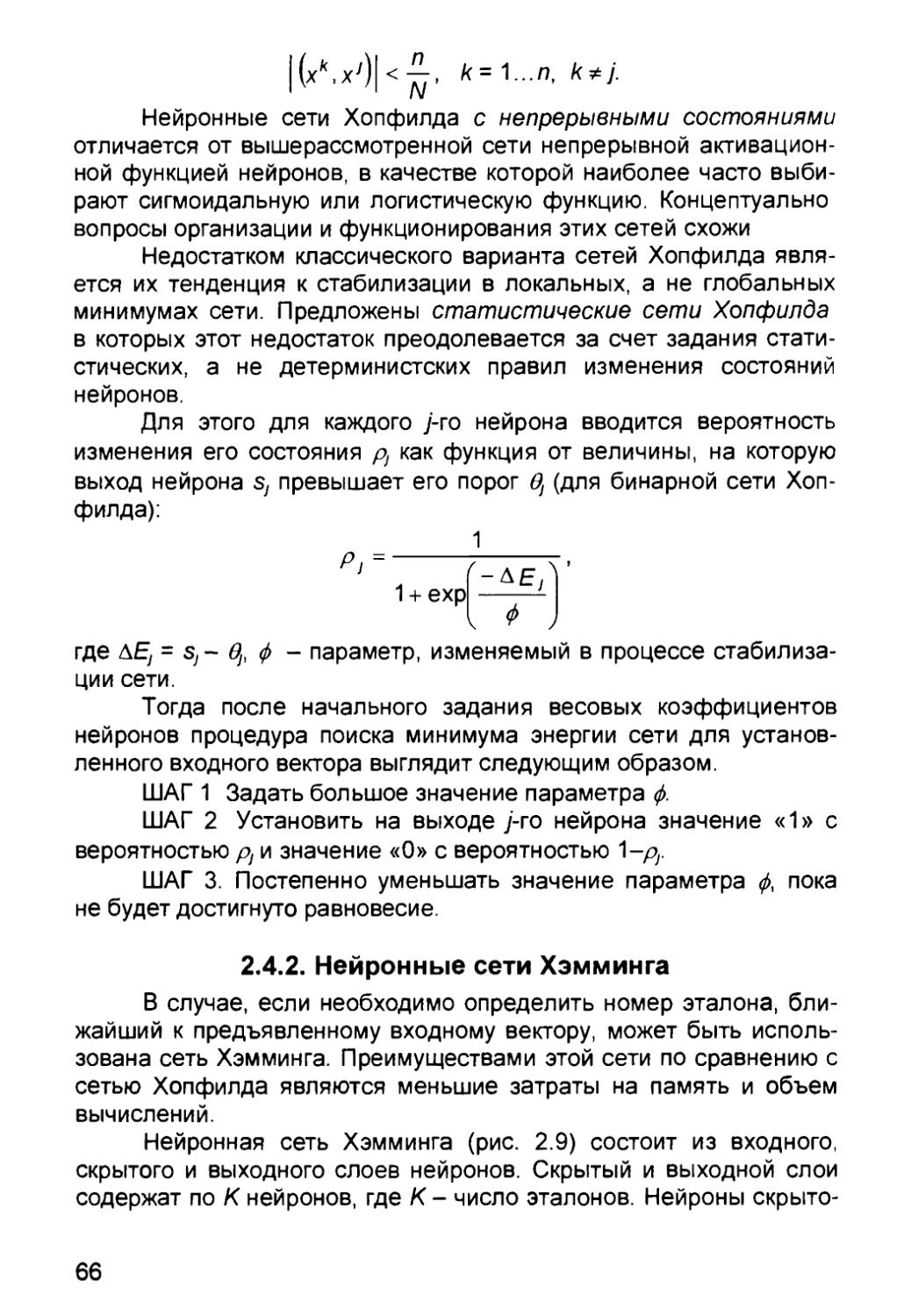

синалтическая пластичность). Впервые предложил правила

обучения нейронной сети

1957 г. Ф. Розенблатт (F. Rosenblatt) разработал принципы

организации и функционирования персептронов, предложил

вариант технической реализации первого в мире нейрокомпьютера

Mark.

1959 г. Д. Хьюбел (D. Hubel) и Т. Визель (Т. Wiesel) показали

распределенный и параллельный характер хранения и обработки

информации в биологических нейронных сетях.

1960-1968 гг. Активные исследования в области

искусственных нейронных сетей, например, АДАЛИНА и МАДАЛИНА В. Уидроу

(W. Widrow) (1960-1962 гг.), ассоциативные матрицы К. Штайнбуха

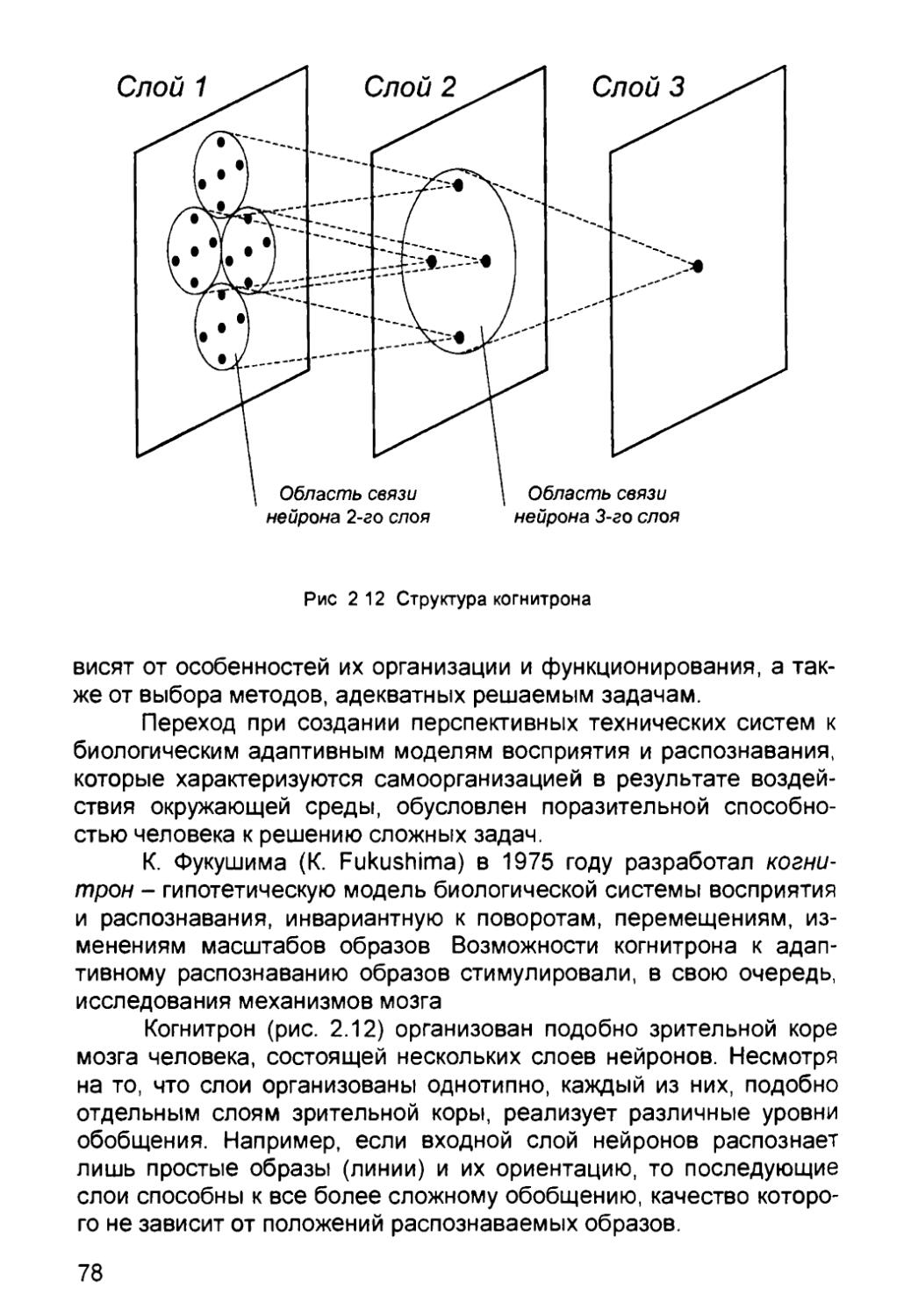

(К. Steinbuch) (1961 г.).

1969 г. Публикация книги М. Минского (М. Minsky) и С. Пей-

перта (S. Papert) «Персептроны», в которой доказывается

принципиальная ограниченность возможностей персептронов. Угасание

интереса к искусственным нейронным сетям.

1970-1976 гг. Активные разработки в области персептронов

в СССР (основные заказчики - военные ведомства).

Конец 1970-х гг. Возобновление интереса к искусственным

нейронным сетям как следствие накопления новых знаний о

деятельности мозга, а также значительного прогресса в области

микроэлектроники и компьютерной техники.

1982-1985 гг. Дж. Хопфилд (J. Hopfield) предложил

семейство оптимизирующих нейронных сетей, моделирующих

ассоциативную память.

1985 г. Появление первых коммерческих нейрокомпьютеров,

например, Mark III фирмы TRW (США).

1987 г. Начало широкомасштабного финансирования

разработок в области ИНС и НК в США, Японии и Западной Европе

(японская программа «Human Frontiers» и европейская программа

«Basic Research in Adaptive Intelligence and Neurocomputing»).

1989 г. Разработки и исследования в области ИНС и НК

ведутся практически всеми крупными электротехническими

фирмами. Нейрокомпьютеры становятся одним из самых динамичных

секторов рынка (за два года объем продаж вырос в пять раз).

Агентством DARPA (Defence Advanced Research Projects Agency)

министерства обороны США начато финансирование программы

по созданию сверхбыстродействующих образцов НК для

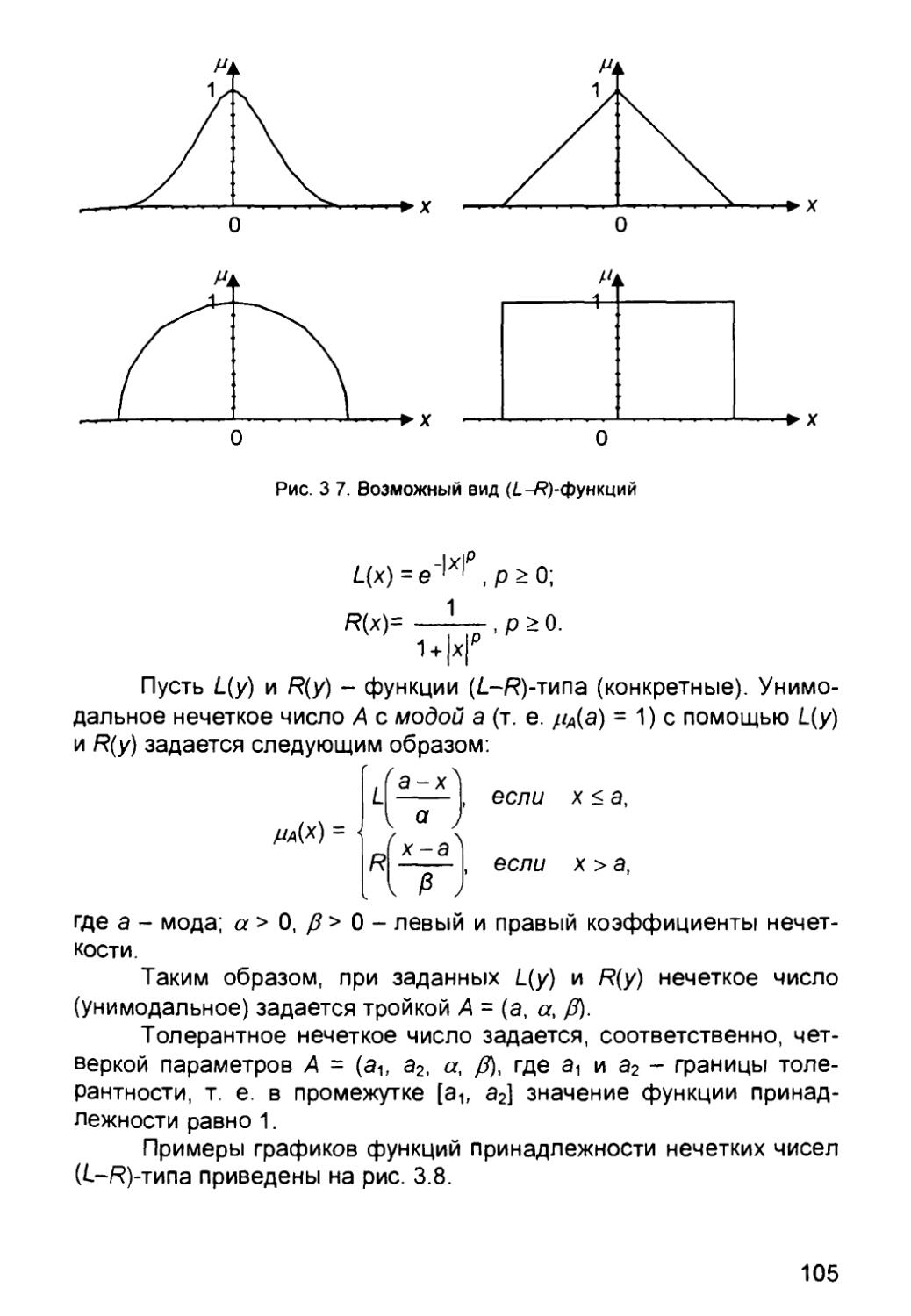

разнообразных применений.

1990 г. Активизация советских исследовательских

организаций в области ИНС и НК (Институт кибернетики им. Глушкова в

Киеве, Институт многопроцессорных вычислительных систем в

Таганроге, Институт нейрокибернетики в Ростове-на-Дону). Общее

число фирм, специализирующихся в области ИНС и НК, достигает

трехсот.

1991 г. Годовой объем продаж на рынке ИНС и НК

приблизился к 140 млн. долларам. Создаются центры нейрокомпьютеров

в Москве, Киеве, Минске, Новосибирске, С.-Петербурге.

1992 г. Работы в области ИНС находятся стадии

интенсивного развития. Ежегодно проводится десятки международных

конференций и форумов по нейронным сетям, число специализирован-

ных периодических научных изданий по указанной тематике

достигло двух десятков наименований.

1996 г. Число международных конференций по ИНС и НК

достигло ста.

1997 г. Годовой объем продаж на рынке ИНС и НК превысил

2 млрд. долларов, а ежегодный прирост составил 50%.

2000 г. Переход на субмикронные и нанотехнологии, а также

успехи молекулярной и биомолекулярной технологии приводят к

принципиально новым архитектурным и технологическим

решениям по созданию нейрокомпьютеров.

Глубокое изучение ИНС требует знания нейрофизиологии,

науки о познании, психологии, физики (статистической механики),

теории управления, теории вычислений, проблем искусственного

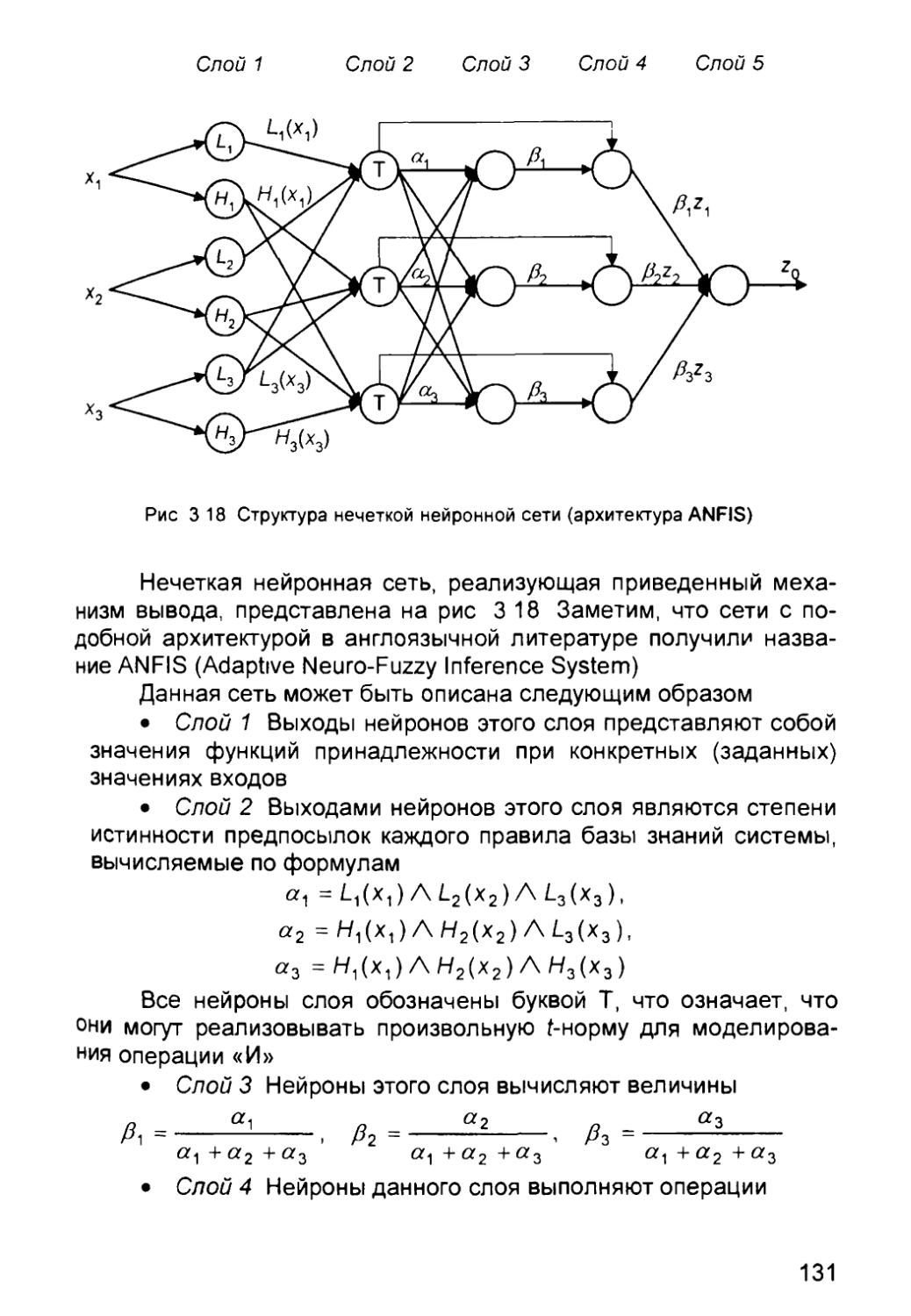

интеллекта, статистики/математики, распознавания образов,

компьютерного зрения, параллельных вычислений и аппаратных

средств (цифровых и аналоговых). С другой стороны, ИНС также

стимулируют эти дисциплины, обеспечивая их новыми

инструментами и представлениями. Этот симбиоз жизненно необходим для

исследования нейронных сетей.

Представим некоторые проблемы, решаемые

искусственными нейронными сетями.

Классификация образов. Задача состоит в указании

принадлежности входного образа, представленного вектором признаков,

одному или нескольким предварительно определенным классам. К

известным приложениям относятся распознавание букв,

распознавание речи, классификация сигнала электрокардиограммы,

классификация клеток крови.

Кластеризация/категоризация. При решении задачи

кластеризации, которая известна также как классификация образов

без учителя, отсутствует обучающая выборка с метками классов.

Алгоритм кластеризации основан на подобии образов и размещает

близкие образы в один кластер. Известны случаи применения

кластеризации для извлечения знаний, сжатия данных и

исследования свойств данных.

Аппроксимация функций. Предположим, что имеется

обучающая выборка ((Xi, ут), (х2) у2), .., (xWl yw)), которая генерируется

неизвестной функцией, искаженной шумом. Задача аппроксимации

состоит в нахождении оценки этой функции.

Предсказание/прогноз. Пусть заданы N дискретных отсчетов

ММ. У(Ь), •••. У(М} в последовательные моменты времени U, fe, ...,

fo . Задача состоит в предсказании значения y(fo+i) в момент fo+i.

Прогноз имеют значительное влияние на принятие решений в

бизнесе, науке и технике.

Оптимизация. Многочисленные проблемы в математике,

статистике, технике, науке, медицине и экономике могут

рассматриваться как проблемы оптимизации. Задачей оптимизации

является нахождение решения, которое удовлетворяет системе

ограничений и максимизирует или минимизирует целевую функцию.

Память, адресуемая по содержанию. В модели вычислений

фон Неймана обращение к памяти доступно только посредством

адреса, который не зависит от содержания памяти. Более того,

если допущена ошибка в вычислении адреса, то может быть

найдена совершенно иная информация. Память, адресуемая по

содержанию, или ассоциативная память, доступна по указанию

заданного содержания. Содержимое памяти может быть вызвано

даже по частичному или искаженному содержанию. Ассоциативная

память чрезвычайно желательна при создании перспективных

информационно-вычислительных систем.

Управление. Рассмотрим динамическую систему, заданную

совокупностью {u(t), y(t)}, где u{t) является входным управляющим

воздействием, a y(t) - выходом системы в момент времени f. В

системах управления с эталонной моделью целью управления

является расчет такого входного воздействия u(t), при котором

система следует по желаемой траектории, диктуемой эталонной

моделью.

Каким образом нейронная сеть решает все эти, часто не-

формализуемые или трудно формализуемые задачи? Как

известно, для решения таких задач традиционно применяются два

основных подхода. Первый, основанный на правилах (rule-based),

характерен для экспертных систем. Он базируется на описании

предметной области в виде набора правил (аксиом) «если ....

то ...» и правил вывода. Искомое знание представляется в этом

случае теоремой, истинность которой доказывается посредством

построения цепочки вывода. При этом подходе, однако,

необходимо заранее знать весь набор закономерностей, описывающих

предметную область. При использовании другого подхода,

основанного на примерах (case-based), надо лишь иметь достаточное

количество примеров для настройки адаптивной системы с

заданной степенью достоверности Нейронные сети представляют собой

классический пример такого подхода.

Книга состоит из трех частей и приложений. Первая часть

посвящена вопросам теории искусственных нейронных сетей,

вторая - программным оболочкам-имитаторам нейронных сетей, в

третьей приведены конкретные примеры применения нейросетево-

го подхода для решения практических задач. Приложение

содержат данные справочного характера.

Несмотря на огромный интерес, проявляемый к

искусственным нейронным сетям, литература по этому направлению в нашей

стране издается весьма малыми тиражами и является

дефицитной, а зачастую слишком узкоспециализированной и поэтому

трудной для понимания. Целью настоящей книги, в связи с этим,

является знакомство широкого круга заинтересованных лиц с

основными понятиями и методами исследования и применения нейронных

сетей.

Авторы подчеркивают, что изданием данной книги они не

преследуют коммерческие интересы и выражают глубокую

благодарность всем, чьи материалы были использованы в работе.

Часть I

ТЕОРИЯ

Глава 1

ОСНОВНЫЕ ПОЛОЖЕНИЯ ТЕОРИИ

ИСКУССТВЕННЫХ НЕЙРОННЫХ СЕТЕЙ

Под нейронными сетями подразумеваются вычислительные

структуры, которые моделируют простые биологические процессы,

обычно ассоциируемые с процессами человеческого мозга. Они

представляют собой распределенные и параллельные системы,

способные к адаптивному обучению путем анализа положительных

и отрицательных воздействий. Элементарным преобразователем

в данных сетях является искусственный нейрон или просто

нейрон, названный так по аналогии с биологическим прототипом.

К настоящему времени предложено и изучено большое

количество моделей нейроподобных элементов и нейронных сетей,

ряд из которых рассмотрен в настоящей главе.

1.1. Биологический нейрон

Нервная система и мозг человека состоят из нейронов,

соединенных между собой нервными волокнами. Нервные волокна

способны передавать электрические импульсы между нейронами.

Все процессы передачи раздражений от кожи, ушей и глаз к мозгу,

процессы мышления и управления действиями - все это реализо-

8

Сома

Ядро

Рис. 1.1 Взаимосвязь биологических нейронов

вано в живом организме как передача электрических импульсов

между нейронами.

Нейрон (нервная клетка) является особой биологической

клеткой, которая обрабатывает информацию (рис. 1.1). Он состоит

из тела (cell body), или сомы (soma), и отростков нервных волокон

двух типов - дендритов (dendrites), по которым принимаются

импульсы, и единственного аксона (ахоп), по которому нейрон может

передавать импульс. Тело нейрона включает ядро (nucleus),

которое содержит информацию о наследственных свойствах, и плазму,

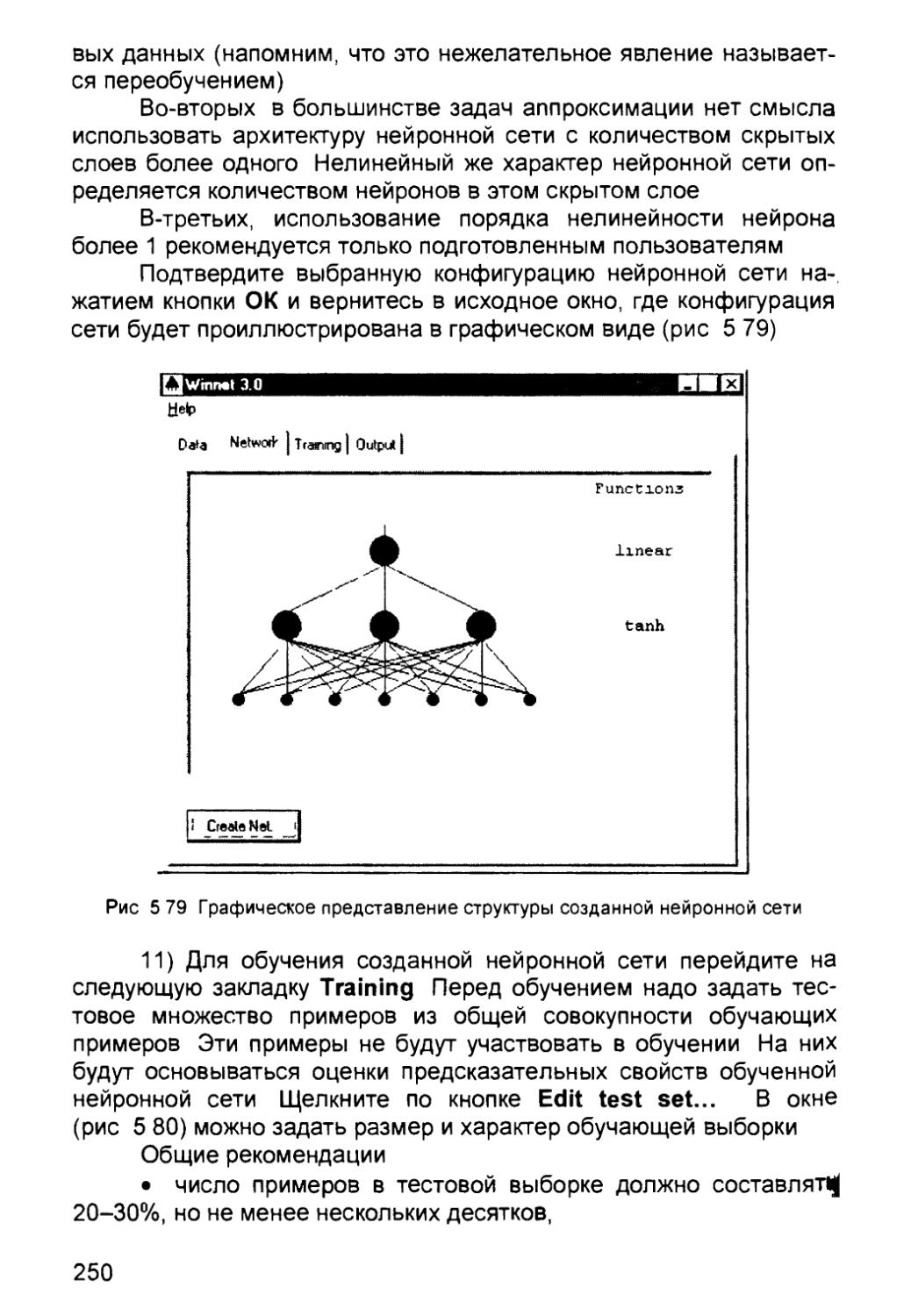

обладающую молекулярными средствами для производства

необходимых нейрону материалов. Нейрон получает сигналы

(импульсы) от аксонов других нейронов через дендриты (приемники) и

передает сигналы, сгенерированные телом клетки, вдоль своего

аксона (передатчика), который в конце разветвляется на волокна

(strands). На окончаниях этих волокон находятся специальные

образования - синапсы (synapses), которые влияют на величину

импульсов.

Синапс является элементарной структурой и

функциональным узлом между двумя нейронами (волокно аксона одного

нейрона и дендрит другого). Когда импульс достигает синаптического

окончания, высвобождаются химические вещества, называемые

нейротрансмиттерами. Нейротрансмиттеры диффундируют через

синаптическую щель, возбуждая или затормаживая, в зависимости

от типа синапса, способность нейрона-приемника генерировать

электрические импульсы Результативность передачи импульса

синапсом может настраиваться проходящими через него

сигналами так, что синапсы могут обучаться в зависимости от активности

процессов, в которых они участвуют. Эта зависимость от

предыстории действует как память, которая, возможно, ответственна за

память человека. Важно отметить, что веса синапсов могут

изменяться со временем, а значит, меняется и поведение

соответствующих нейронов.

Кора головного мозга человека содержит около 1011

нейронов и представляет собой протяженную поверхность толщиной от

2 до 3 мм с площадью около 2200 см2. Каждый нейрон связан с

103-104 другими нейронами. В целом мозг человека содержит

приблизительно от 1014 до 1015 взаимосвязей

Нейроны взаимодействуют короткими сериями импульсов

продолжительностью, как правило, несколько миллисекунд.

Сообщение передается посредством частотно-импульсной модуляции.

Частота может изменяться от нескольких единиц до сотен герц,

что в миллион раз медленнее, чем быстродействующие

переключательные электронные схемы Тем не менее сложные задачи

распознавания человек решает за несколько сотен миллисекунд.

Эти решения контролируются сетью нейронов, которые имеют

скорость выполнения операций всего несколько миллисекунд. Это

означает, что вычисления требуют не более 100

последовательных стадий. Другими словами, для таких сложных задач мозг

«запускает» параллельные программы, содержащие около 100 шагов

Рассуждая аналогичным образом, можно обнаружить, что

количество информации, посылаемое от одного нейрона другому, должно

быть очень малым (несколько бит). Отсюда следует, что основная

информация не передается непосредственно, а захватывается и

распределяется в связях между нейронами.

1.2. Структура и свойства искусственного нейрона

Нейрон является составной частью нейронной сети. На

рис. 1 2 показана его структура Он состоит из элементов трех

типов: умножителей (синапсов), сумматора и нелинейного

преобразователя. Синапсы осуществляют связь между нейронами,

умножают входной сигнал на число, характеризующее силу связи, (вес

синапса). Сумматор выполняет сложение сигналов, поступающих

по синаптическим связям от других нейронов, и внешних входных

сигналов. Нелинейный преобразователь реализует нелинейную

функцию одного аргумента - выхода сумматора. Эта функция

называется функцией активации или передаточной функцией ней-

10

w

Wn

®—►

Рис. 1.2 Структура искусственного нейрона

рона. Нейрон в целом реализует скалярную функцию векторного

аргумента. Математическая модель нейрона:

s= Zw,x, + b, (1.1)

'y = f(s)f (1.2)

где w, - вес (weight) синапса, / = 1...n; b - значение смещения

(bias), s - результат суммирования (sum); x, - компонент входного

вектора (входной сигнал), / = 1...п; у - выходной сигнал нейрона;

п - число входов нейрона; f- нелинейное преобразование

(функция активации).

В общем случае входной сигнал, весовые коэффициенты и

смещение могут принимать действительные значения, а во многих

практических задачах - лишь некоторые фиксированные значения.

Выход (у) определяется видом функции активации и может быть

как действительным, так и целым.

Синаптические связи с положительными весами называют

возбуждающими, с отрицательными весами - тормозящими.

Описанный вычислительный элемент можно считать

упрощенной математической моделью биологических нейронов. Чтобы

подчеркнуть различие нейронов биологических и искусственных,

вторые иногда называют нейроноподобными элементами или

формальными нейронами.

На входной сигнал (s) нелинейный преобразователь

отвечает выходным сигналом f(s), который представляет собой выход у

11

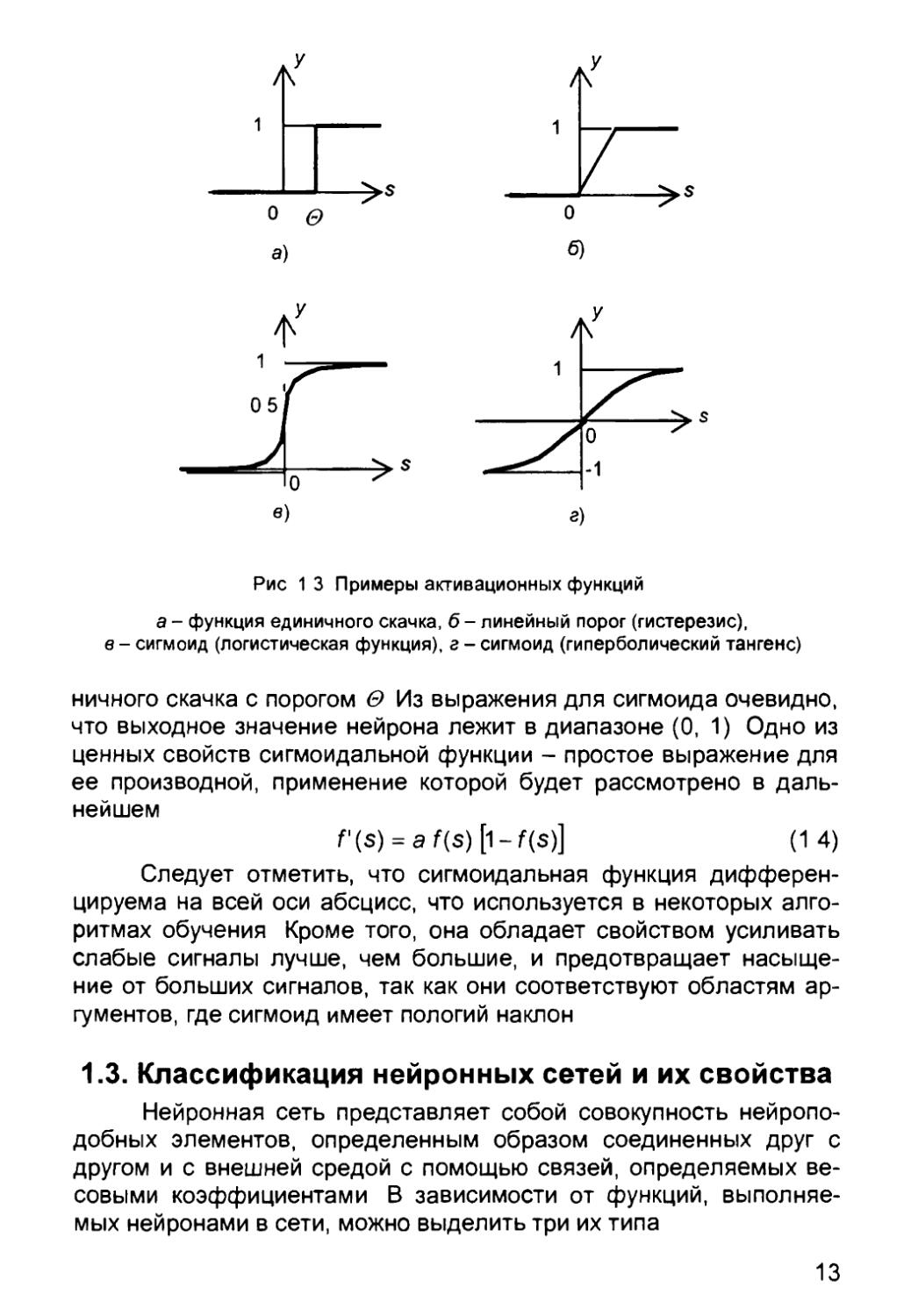

нейрона Примеры активационных функций представлены

табл 1 1 и на рис 1 3

Таблица 1 1

Функции активации нейронов

Название

Линейная

Полулинейная

Логистическая

(сигмоидальная)

Гиперболический

тангенс

(сигмоидальная)

Экспоненциальная

Синусоидальная

Сигмоидальная

(рациональная)

Шаговая

(линейная с

насыщением)

Пороговая

Модульная

Знаковая

(сигнатурная)

Квадратичная

Формула

f(s)=k s

Iks, s > 0,

1

а$ -as

f(r\ e e .

As) = e"as

f(s) - sin(s)

s

a + |s|

f-1, s<-1,

f(s) = Is -1 < s < 1,

[1, s > 0

s

f(s) = s2

Область значений

(—оо, оо)

(0, со)

(0,1)

(-1,1)

(О.»)

(-1,1)

(-1.1)

(-1,1)

(0,1)

(О,»)

(-1.1)

(0. со)

Одной из наиболее распространенных является нелинейна

функция активации с насыщением, так называемая логистически

функция или сигмоид (функция S-образного вида)

f(s) = —-— (1

При уменьшении а сигмоид становится более пологим,

пределе при а = 0 вырождаясь в горизонтальную линию на ypoei

0,5, при увеличении а сигмоид приближается к виду функции ед

12

л

л

о &

а)

О

б)

Л

Рис 1 3 Примеры активационных функций

а - функция единичного скачка, б- линейный порог (гистерезис),

в - сигмоид (логистическая функция), г - сигмоид (гиперболический тангенс)

ничного скачка с порогом О Из выражения для сигмоида очевидно,

что выходное значение нейрона лежит в диапазоне (0, 1) Одно из

ценных свойств сигмоидальной функции - простое выражение для

ее производной, применение которой будет рассмотрено в

дальнейшем

f(s) = af(s)[W(s)] (14)

Следует отметить, что сигмоидальная функция

дифференцируема на всей оси абсцисс, что используется в некоторых

алгоритмах обучения Кроме того, она обладает свойством усиливать

слабые сигналы лучше, чем большие, и предотвращает

насыщение от больших сигналов, так как они соответствуют областям

аргументов, где сигмоид имеет пологий наклон

1.3. Классификация нейронных сетей и их свойства

Нейронная сеть представляет собой совокупность нейропо-

добных элементов, определенным образом соединенных друг с

другом и с внешней средой с помощью связей, определяемых

весовыми коэффициентами В зависимости от функций,

выполняемых нейронами в сети, можно выделить три их типа

13

• входные нейроны, на которые подается вектор,

кодирующий входное воздействие или образ внешней среды; в них обычно

не осуществляется вычислительных процедур, а информация

передается с входа на выход путем изменения их активации;

• выходные нейроны, выходные значения которых

представляют выходы нейронной сети; преобразования в них

осуществляются по выражениям (1.1) и (1.2);

• промежуточные нейроны, составляющие основу

нейронных сетей, преобразования в которых выполняются также по

выражениям (1.1) и (1.2).

В большинстве нейронных моделей тип нейрона связан с его

расположением в сети. Если нейрон имеет только выходные связи,

то это входной нейрон, если наоборот - выходной нейрон. Однако

возможен случай, когда выход топологически внутреннего нейрона

рассматривается как часть выхода сети. В процессе

функционирования сети осуществляется преобразование входного вектора в

выходной, некоторая переработка информации. Конкретный вид

выполняемого сетью преобразования данных обусловливается не

только характеристиками нейроподобных элементов, но и

особенностями ее архитектуры, а именно топологией межнейронных

связей, выбором определенных подмножеств нейроподобных

элементов для ввода и вывода информации, способами обучения сети,

наличием или отсутствием конкуренции между нейронами,

направлением и способами управления и синхронизации передачи

информации между нейронами.

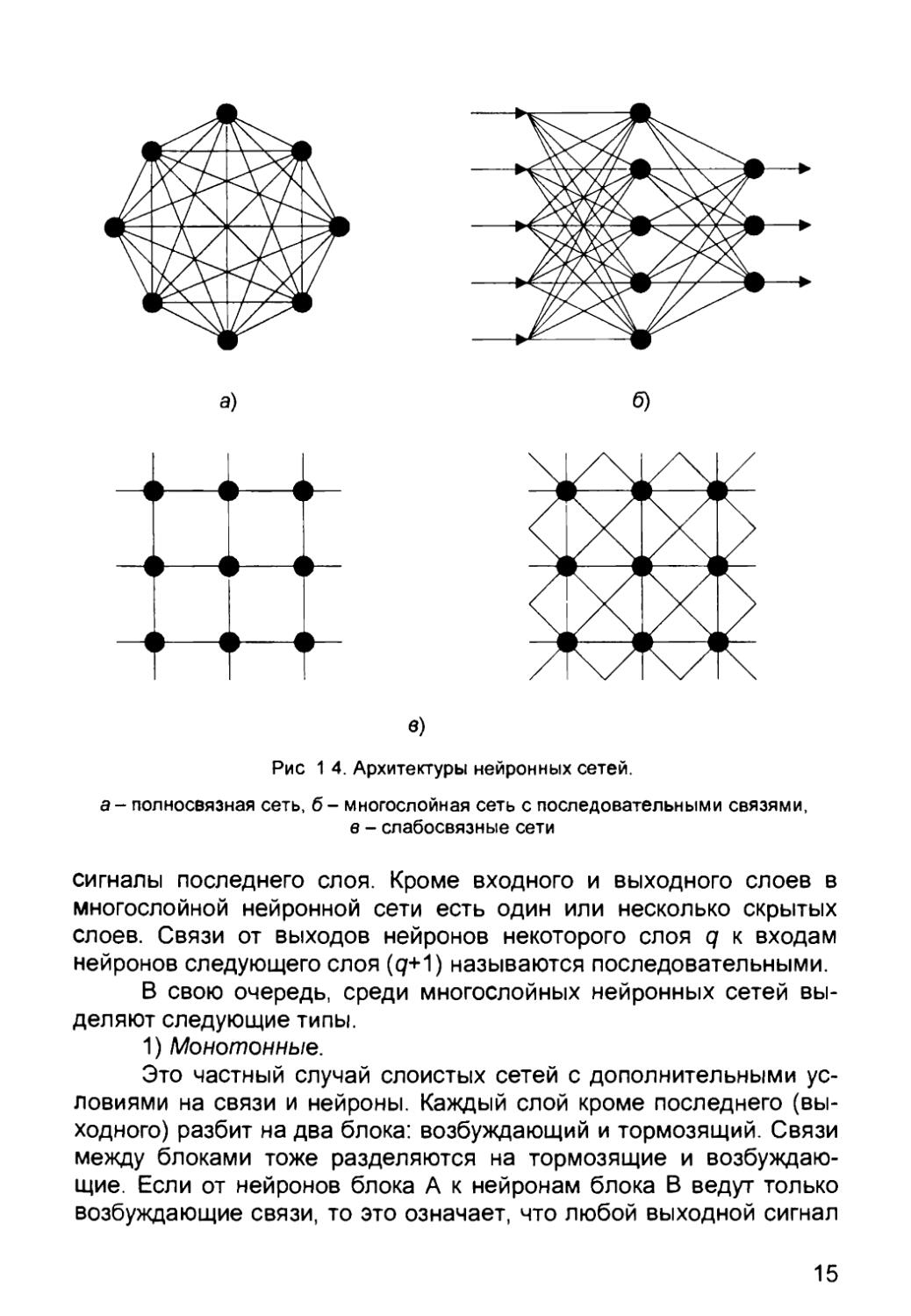

С точки зрения топологии можно выделить три основных

типа нейронных сетей:

• полносвязные (рис. 1.4, а);

• многослойные или слоистые (рис. 1.4, б);

• слабосвязные (с локальными связями) (рис. 1.4, б).

В полносвязных нейронных сетях каждый нейрон передает

свой выходной сигнал остальным нейронам, в том числе и самому

себе. Все входные сигналы подаются всем нейронам. Выходными

сигналами сети могут быть все или некоторые выходные сигналы

нейронов после нескольких тактов функционирования сети.

В многослойных нейронных сетях нейроны объединяются в

слои. Слой содержит совокупность нейронов с едиными входными

сигналами Число нейронов в слое может быть любым и не

зависит от количества нейронов в других слоях. В общем случае сеть

состоит из Q слоев, пронумерованных слева направо. Внешние

входные сигналы подаются на входы нейронов входного слоя (его

часто нумеруют как нулевой), а выходами сети являются выходные

14

б)

в)

Рис 1 4. Архитектуры нейронных сетей.

а- полносвязная сеть, б- многослойная сеть с последовательными связями,

в - слабосвязные сети

сигналы последнего слоя. Кроме входного и выходного слоев в

многослойной нейронной сети есть один или несколько скрытых

слоев. Связи от выходов нейронов некоторого слоя q к входам

нейронов следующего слоя (q+1) называются последовательными.

В свою очередь, среди многослойных нейронных сетей

выделяют следующие типы.

1) Монотонные.

Это частный случай слоистых сетей с дополнительными

условиями на связи и нейроны. Каждый слой кроме последнего

(выходного) разбит на два блока: возбуждающий и тормозящий. Связи

между блоками тоже разделяются на тормозящие и

возбуждающие. Если от нейронов блока А к нейронам блока В ведут только

возбуждающие связи, то это означает, что любой выходной сигнал

15

Входной слой Скрытый слой Выходной слой

Рис 1 5 Многослойная (двухслойная) сеть прямого распространения

блока является монотонной неубывающей функцией любого

выходного сигнала блока А Если же эти связи только тормозящие, то

любой выходной сигнал блока В является невозрастающей

функцией любого выходного сигнала блока А Для нейронов

монотонных сетей необходима монотонная зависимость выходного

сигнала нейрона от параметров входных сигналов

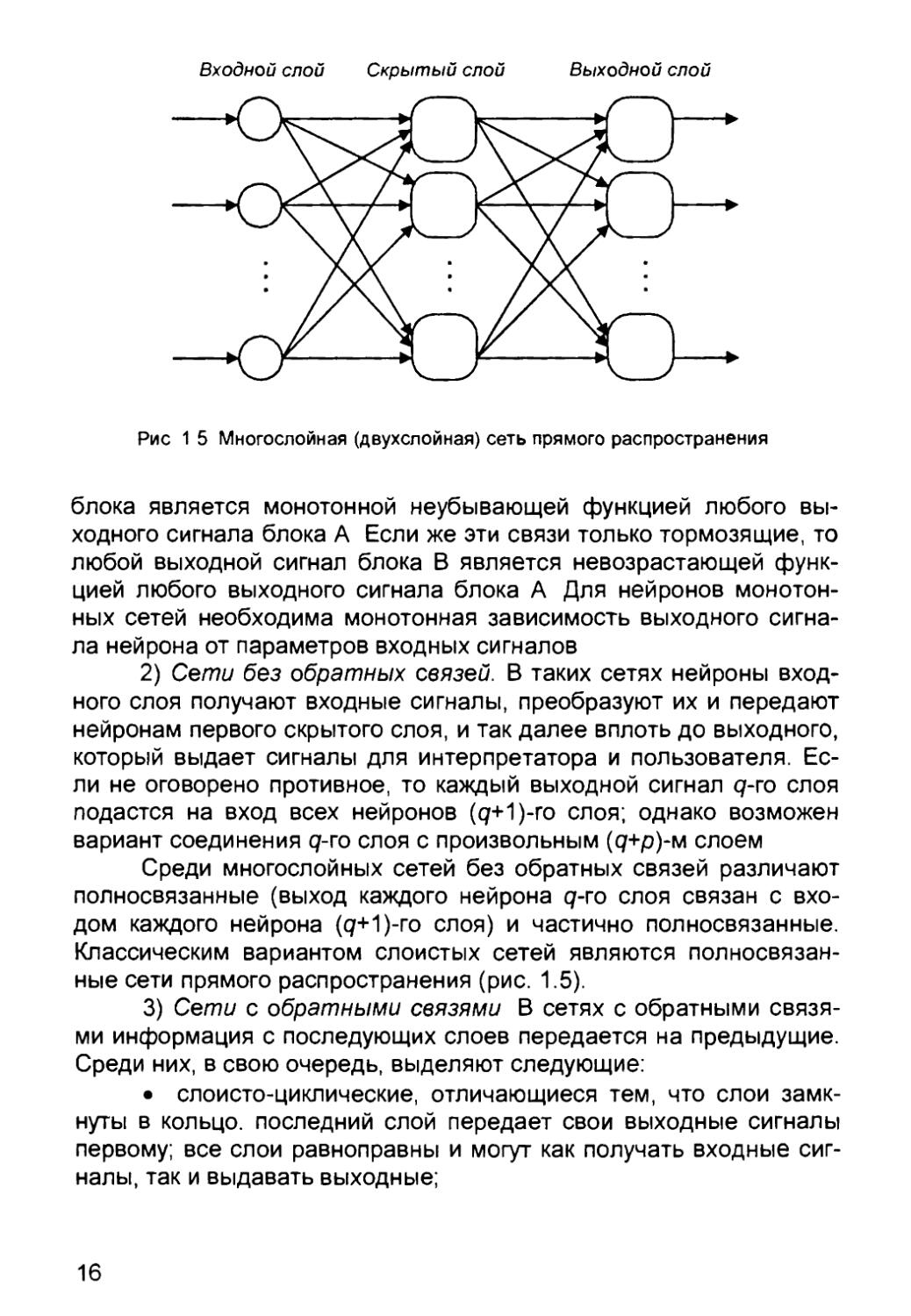

2) Сети без обратных связей. В таких сетях нейроны

входного слоя получают входные сигналы, преобразуют их и передают

нейронам первого скрытого слоя, и так далее вплоть до выходного,

который выдает сигналы для интерпретатора и пользователя.

Если не оговорено противное, то каждый выходной сигнал g-го слоя

подастся на вход всех нейронов (с/+1)-го слоя; однако возможен

вариант соединения g-го слоя с произвольным (д+р)-м слоем

Среди многослойных сетей без обратных связей различают

полносвязанные (выход каждого нейрона g-го слоя связан с

входом каждого нейрона (д+1)-го слоя) и частично полносвязанные.

Классическим вариантом слоистых сетей являются

полносвязанные сети прямого распространения (рис. 1.5).

3) Сети с обратными связями В сетях с обратными

связями информация с последующих слоев передается на предыдущие.

Среди них, в свою очередь, выделяют следующие:

• слоисто-циклические, отличающиеся тем, что слои

замкнуты в кольцо, последний слой передает свои выходные сигналы

первому; все слои равноправны и могут как получать входные

сигналы, так и выдавать выходные;

16

• слоисто-полносвязанные состоят из слоев, каждый из

которых представляет собой полносвязную сеть, а сигналы

передаются как от слоя к слою, так и внутри слоя; в каждом слое цикл

работы распадается на три части, прием сигналов с предыдущего

слоя, обмен сигналами внутри слоя, выработка выходного сигнала

и передача к последующему слою,

• полносвязанно-слоистые, по своей структуре

аналогичные слоисто-полносвязанным, но функционирующим по-другому: в

них не разделяются фазы обмена внутри слоя и передачи

следующему, на каждом такте нейроны всех слоев принимают

сигналы от нейронов как своего слоя, так и последующих

В качестве примера сетей с обратными связями на рис. 1 6

представлены частично-рекуррентные сети Элмана и Жордана.

Выход

Выход

Контекстные

нейроны

Выходной слой

Скрытый слой

Вход

Выход

Выход

г

^>

Контекстные

нейроны

\

Выходной слой

Скрытый слой

Вход]

с г я

Контекстные

нейроны

Вход

б)

Рис 1 6 Частично-рекуррентные сети

а - Элмана, б - Жордана

17

В слабосвязных нейронных сетях нейроны располагаются в

узлах прямоугольной или гексагональной решетки Каждый нейрон

связан с четырьмя (окрестность фон Неймана), шестью

(окрестность Голея) или восемью (окрестность Мура) своими ближайшими

соседями.

Известные нейронные сети можно разделить по типам

структур нейронов на гомогенные (однородные) и гетерогенные.

Гомогенные сети состоят из нейронов одного типа с единой функцией

активации, а в гетерогенную сеть входят нейроны с различными

функциями активации.

Существуют бинарные и аналоговые сети. Первые из них

оперируют только двоичными сигналами, и выход каждого нейрона

может принимать значение либо логического ноля (заторможенное

состояние) либо логической единицы (возбужденное состояние).

Еще одна классификация делит нейронные сети на

синхронные и асинхронные. В первом случае в каждый момент времени

лишь один нейрон меняет свое состояние, во втором - состояние

меняется сразу у целой группы нейронов, как правило, у всего

слоя. Алгоритмически ход времени в нейронных сетях задается

итерационным выполнением однотипных действий над нейронами

Далее будут рассматриваться только синхронные сети

Сети можно классифицировать также по числу слоев.

Теоретически число слоев и число нейронов в каждом слое может быть

произвольным, однако фактически оно ограничено ресурсами

компьютера или специализированных микросхем, на которых обычно

реализуется нейронная сеть. Чем сложнее сеть, тем более

сложные задачи она может решать.

Выбор структуры нейронной сети осуществляется в

соответствии с особенностями и сложностью задачи. Для решения

отдельных типов задач уже существуют оптимальные конфигурации,

описанные в приложении. Если же задача не может быть сведена

ни к одному из известных типов, приходится решать сложную

проблему синтеза новой конфигурации. При этом необходимо

руководствоваться следующими основными правилами:

• возможности сети возрастают с увеличением числа

нейронов сети, плотности связей между ними и числом слоев;

• введение обратных связей наряду с увеличением

возможностей сети поднимает вопрос о динамической устойчивости

сети;

• сложность алгоритмов функционирования сети, введение

нескольких типов синапсов способствует усилению мощности

нейронной сети.

18

Вопрос о необходимых и достаточных свойствах сети для

решения задач того или иного рода представляет собой целое

направление нейрокомпьютерной науки. Так как проблема синтеза

нейронной сети сильно зависит от решаемой задачи, дать общие

подробные рекомендации затруднительно В большинстве случаев

оптимальный вариант получается на основе интуитивного

подбора, хотя в литературе приведены доказательства того, что для

любого алгоритма существует нейронная сеть, которая может его

реализовать. Остановимся на этом подробнее.

Многие задачи распознавания образов (зрительных,

речевых), выполнения функциональных преобразований при обработке

сигналов, управления, прогнозирования, идентификации сложных

систем, сводятся к следующей математической постановке.

Необходимо построить такое отображение X ~> У, чтобы на каждый

возможный входной сигнал X формировался правильный

выходной сигнал У. Отображение задается конечным набором пар

(<вход>, <известный выход>). Число этих пар (обучающих

примеров) существенно меньше общего числа возможных сочетаний

значений входных и выходных сигналов. Совокупность всех

обучающих примеров носит название обучающей выборки.

В задачах распознавания образов X - некоторое

представление образа (изображение, вектор), У- номер класса, к которому

принадлежит входной образ.

В задачах управления X - набор контролируемых

параметров управляемого объекта, У - код, определяющий управляющее

воздействие, соответствующее текущим значениям

контролируемых параметров.

В задачах прогнозирования в качестве входных сигналов

используются временные ряды, представляющие значения

контролируемых переменных на некотором интервале времени.

Выходной сигнал - множество переменных, которое является

подмножеством переменных входного сигнала.

При идентификации X и У представляют входные и

выходные сигналы системы соответственно.

Вообще говоря, большая часть прикладных задач может

быть сведена к реализации некоторого сложного функционального

многомерного преобразования.

В результате отображения X ~> У необходимо обеспечить

формирование правильных выходных сигналов в соответствии:

• со всеми примерами обучающей выборки;

• со всеми возможными входными сигналами, которые не

вошли в обучающую выборку.

19

Второе требование в значительной степени усложняет

задачу формирования обучающей выборки В общем виде эта задача в

настоящее время еще не решена однако во всех известных

случаях может быть найдено частное решение

1.3.1. Теорема Колмогорова-Арнольда

Построить многомерное отображение X -> У - это значит

представить его с помощью математических операций над не

более, чем двумя переменными

Проблема представления функций многих переменных в

виде суперпозиции функций меньшего числа переменных восходит

13-й проблеме Гильберта В результате многолетней научной

полемики между А Н Колмогоровым и В И Арнольдом был получен

ряд важных теоретических результатов, опровергающих тезис

непредставимости функции многих переменных функциями

меньшего числа переменных

• теорема о возможности представления непрерывных

функций нескольких переменных суперпозициями непрерывных

функций меньшего числа переменных (1956 г),

• теорема о представлении любой непрерывной функции

трех переменных в виде суммы функций не более двух

переменных (1957 г),

• теорема о представлении непрерывных функций

нескольких переменных в виде суперпозиций непрерывных функций

одного переменного и сложения (1957 г)

1.3.2. Работа Хехт-Нильсена

Теорема о представлении непрерывных функций нескольких

переменных в виде суперпозиций непрерывных функций одного

переменного и сложения в 1987 году была переложена Хехт-

Нильсеном для нейронных сетей

Теорема Хехт-Нильсена доказывает представимость

функции многих переменных достаточно общего вида с помощью

двухслойной нейронной сети с прямыми полными связями с п

нейронами входного слоя, (2п+1) нейронами скрытого слоя с заранее

известными ограниченными функциями активации (например, сиг-

моидальными) и т нейронами выходного слоя с неизвестными

функциями активации

Теорема, таким образом, в неконструктивной форме

доказывает решаемость задачи представления функции произвольного

вида на нейронной сети и указывает для каждой задачи

минимальные числа нейронов сети, необходимых для ее решения

20

1.3.3. Следствия из теоремы

Колмогорова-Арнольда - Хехт-Нильсена

Следствие 1 Из теоремы Хехт-Нильсена следует

представимость любой многомерной функции нескольких переменных с

помощью нейронной сети фиксированной размерности

Неизвестными остаются следующие характеристики функций активации

нейронов

• ограничения области значений (координаты асимптот)

сигмоидальных функций активации нейронов скрытого слоя,

• наклон сигмоидальных функций активации,

• вид функций активации нейронов выходного слоя

Про функции активации нейронов выходного слоя из

теоремы Хехт-Нильсена известно только то, что они представляют

собой нелинейные функции общего вида В одной из работ,

продолжающих развитие теории, связанной с рассматриваемой теоремой,

доказывается, что функции активации нейронов выходного слоя

должны быть монотонно возрастающими Это утверждение в

некоторой степени сужает класс функций, которые могут

использоваться при реализации отображения с помощью двухслойной

нейронной сети

На практике требования теоремы Хехт-Нильсена к функциям

активации удовлетворяются следующим образом В нейронных

сетях как для первого (скрытого), так и для второго (выходного)

слоя используют сигмоидальные передаточные функции с

настраиваемыми параметрами То есть в процессе обучения

индивидуально для каждого нейрона задается максимальное и

минимальное значение, а также наклон сигмоидальной функции

Следствие 2 Для любого множества пар ()г, г ) (где У* -

скаляр) существует двухслойная однородная (с одинаковыми

функциями активации) нейронная сеть первого порядка с

последовательными связями и с конечным числом нейронов, которая

выполняет отображение X -+ У, выдавая на каждый входной сигнал

X* правильный выходной сигнал г Нейроны в такой двухслойной

нейронной сети должны иметь сигмоидальные передаточные

функции

К сожалению, эта теорема не конструктивна В ней не

заложена методика определения числа нейронов в сети для некоторой

конкретной обучающей выборки

Для многих задач единичной размерности выходного

сигнала недостаточно Необходимо иметь возможность строить с

помощью нейронных сетей функции X -+ У, где У имеет произвольную

размерность Следующее утверждение является теоретической

21

основой для построения таких функций на базе однородных

нейронных сетей.

Утверждение. Для любого множества пар входных-

выходных векторов произвольной размерности {(X*, У*), к = 1...Л/}

существует однородная двухслойная нейронная сеть с

последовательными связями, с сигмоидальными передаточными функциями

и с конечным числом нейронов, которая для каждого входного

вектора Сформирует соответствующий ему выходной вектор Y*.

Таким образом, для представления многомерных функций

многих переменных может быть использована однородная

двухслойная нейронная сеть с сигмоидальными передаточными

функциями.

Для оценки числа нейронов с скрытых слоях однородных

нейронных сетей можно воспользоваться формулой для оценки

необходимого числа синаптических весов Lw в многослойной сети с

сигмоидальными передаточными функциями:

< Lw ^ т\ — +1 (л + m +1) + Л7, (1.5)

1 + log2/V w {m

где п - размерность входного сигнала, т - размерность выходного

сигнала, N - число элементов обучающей выборки.

Оценив необходимое число весов, можно рассчитать число

нейронов в скрытых слоях. Например, для двухслойной сети это

число составит:

^. (1.6)

п + т

Известны и другие формулы для оценки, например:

2(л + L + т) < N < Щп + L + ш), (1.7)

N N

n-m <L< п-т . (1.8)

10 2 v

Точно так же можно рассчитать число нейронов в сетях с

большим числом слоев.

Иногда целесообразно использовать сети с большим числом

слоев. Такие многослойные нейронные сети могут иметь меньшие

размерности матриц синаптических весов нейронов одного слоя,

чем двухслойные сети, реализующие то же самое отображение.

Однако строгой методики построения таких сетей пока нет.

Аналогичная ситуация складывается и с многослойными

нейронными сетями, в которых помимо последовательных связей

используются и прямые (связи от слоя с номером q к слою с

номером (q+p), где р > 1). Нет строгой теории, которая показывала бы

возможность и целесообразность построения таких сетей.

22

Наибольшие проблемы возникают при использовании сетей

циклического функционирования. К этой группе относятся

многослойные сети с обратными связями (от слоя с номером q к слою с

номером (Q+p), где р < 0), а также полносвязные сети. Для

успешного функционирования таких сетей необходимо соблюдение

условий динамической устойчивости, иначе сеть может не сойтись к

правильному решению, либо, достигнув на некоторой итерации

правильного значения выходного сигнала, после нескольких

итераций уйти от этого значения. Проблема динамической

устойчивости подробно исследована, пожалуй, лишь для одной модели из

рассматриваемой группы - нейронной сети Хопфилда.

Отсутствие строгой теории для перечисленных моделей

нейронных сетей не препятствует исследованию возможностей их

применения.

Отметим, что отечественному читателю приведенные

результаты известны в более фрагментарной форме - в виде так

называемой теоремы о полноте.

Теорема о полноте.

Любая непрерывная функция на замкнутом ограниченном

множестве может быть равномерно приближена функциями,

вычисляемыми нейронными сетями, если функция активации

нейрона дважды непрерывно дифференцируема и непрерывна.

Таким образом, нейронные сети являются универсальными

структурами, позволяющими реализовать любой вычислительный

алгоритм.

1.4. Постановка и возможные пути решения

задачи обучения нейронных сетей

Очевидно, что процесс функционирования нейронной сети,

сущность действий, которые она способна выполнять, зависит от

величин синаптических связей. Поэтому, задавшись определенной

структурой сети, соответствующей какой-либо задаче, необходимо

найти оптимальные значения всех переменных весовых

коэффициентов (некоторые синаптические связи могут быть

постоянными).

Этот этап называется обучением нейронной сети, и от того,

насколько качественно он будет выполнен, зависит способность

сети решать поставленные перед ней проблемы во время

функционирования.

В процессе функционирования нейронная сеть формирует

выходной сигнал У в соответствии с входным сигналом X,

реализуя некоторую функцию д: У = д(Х). Если архитектура сети задана,

23

то вид функции д определяется значениями синаптических весов и

смещений сети. Обозначим через G множество всех возможных

функций д, соответствующих заданной архитектуре сети.

Пусть решение некоторой задачи есть функция г У - г{Х),

заданная парами входных-выходных данных (X1, У1), .... (X*, У*),

для которых У* = а{Х*), к = 1 . N. Е - функция ошибки (функционал

качества), показывающая для каждой из функций д степень

близости к г.

Решить поставленную задачу с помощью нейронной сети

заданной архитектуры - это значит построить (синтезировать)

функцию д g G, подобрав параметры нейронов (синаптические

веса и смещения) таким образом, чтобы функционал качества

обращался в оптимум для всех пар (X*, У*).

Таким образом, задача обучения нейронной сети

определяется совокупностью пяти компонентов:

<Х, У, г, G, £>.

Обучение состоит в поиске (синтезе) функции д,

оптимальной по Е. Оно требует длительных вычислений и представляет

собой итерационную процедуру. Число итераций может составлять

от 103 до 108. На каждой итерации происходит уменьшение

функции ошибки.

Функция £ может иметь произвольный вид. Если выбраны

множество обучающих примеров и способ вычисления функции

ошибки, обучение нейронной сети превращается в задачу

многомерной оптимизации, для решения которой могут быть

использованы следующие методы:

• локальной оптимизации с вычислением частных

производных первого порядка;

• локальной оптимизации с вычислением частных

производных первого и второго порядка;

• стохастической оптимизации;

• глобальной оптимизации.

К первой группе относятся: градиентный метод

(наискорейшего спуска); методы с одномерной и двумерной оптимизацией

целевой функции в направлении антиградиента; метод

сопряженных градиентов; методы, учитывающие направление

антиградиента на нескольких шагах алгоритма.

Ко второй группе относятся' метод Ньютона, методы

оптимизации с разреженными матрицами Гессе, квазиньютоновские

методы, метод Гаусса-Ньютона, метод Левенберга-Маркардта.

24

Стохастическими методами являются: поиск в случайном

направлении, имитация отжига, метод Монте-Карло (численный

метод статистических испытаний).

Задачи глобальной оптимизации решаются с помощью

перебора значений переменных, от которых зависит целевая

функция.

Для сравнения методов обучения нейронных сетей

необходимо использовать два критерия:

• количество шагов алгоритма для получения решения;

• количество дополнительных переменных для

организации вычислительного процесса.

Для иллюстрации термина «дополнительные переменные»

приведем следующий пример. Пусть р<\ и р2 - некоторые

параметры нейронной сети с заданными значениями. В процессе обучения

сети на каждом шаге, по меньшей мере, два раза потребуется

выполнить умножение рф2. Дополнительная переменная требуется

для сохранения значение произведения после первого умножения.

Предпочтение следует отдавать тем методам, которые

позволяют обучить нейронную сеть за небольшое число шагов и

требуют малого числа дополнительных переменных. Это связано с

ограничением ресурсов вычислительных средств. Как правило,

для обучения используются персональные компьютеры.

Пусть нейронная сеть содержит Р изменяемых параметров

(синаптических весов и смещений). Существует лишь две группы

алгоритмов обучения, которые требуют менее 2Р дополнительных

параметров и при этом дают возможность обучать нейронные сети

за приемлемое число шагов. Это алгоритмы с вычислением

частных производных первого порядка и, возможно, одномерной

оптимизации. Именно эти алгоритмы и будут рассмотрены в

следующих разделах.

Хотя указанные алгоритмы дают возможность находить

только локальные экстремумы, они могут быть использованы на

практике для обучения нейронных сетей с многоэкстремальными

целевыми функциями (функциями ошибки), так как экстремумов у

целевой функции, как правило, не очень много. Достаточно лишь

раз или два вывести сеть из локального минимума с большим

значением целевой функции для того, чтобы в результате итераций в

соответствии с алгоритмом локальной оптимизации сеть оказалась

в локальном минимуме со значением целевой функции, близким к

нулю Если после нескольких попыток вывести сеть из локального

минимума нужного эффекта добиться не удается, необходимо

увеличить число нейронов во всех слоях с первого по предпослед-

25

ний и присвоить случайным образом их синаптическим весам и

смещениям значения из заданного диапазона

Эксперименты по обучению нейронных сетей показали, что

совместное использование алгоритма локальной оптимизации

процедуры вывода сети из локального минимума и процедуры

увеличения числа нейронов приводит к успешному обучению

нейронных сетей

Кратко опишем недостатки других методов Стохастические

алгоритмы требуют очень большого числа шагов обучения Это

делает невозможным их практическое использование для

обучения нейронных сетей больших размерностей Экспоненциальный

рост сложности перебора с ростом размерности задачи в

алгоритмах глобальной оптимизации при отсутствии априорной

информации о характере целевой функции также делает невозможным их

использование для обучения нейронных сетей больших

размерностей Метод сопряженных градиентов очень чувствителен к

точности вычислений, особенно при решении задач оптимизации

большой размерности Для методов, учитывающих направление

антиградиента на нескольких шагах алгоритма, и методов, включающих

вычисление матрицы Гессе, необходимо более чем 2Р

дополнительных переменных В зависимости от способа разрежения,

вычисление матрицы Гессе требует от 2Р до Р2 дополнительных

переменных

Рассмотрим один из самых распространенных алгоритмов

обучения - алгоритм обратного распространения ошибки

1.4.1. Обучение с учителем.

Алгоритм обратного распространения ошибки

В многослойных нейронных сетях оптимальные выходные

значения нейронов всех слоев, кроме последнего, как правило,

неизвестны Трех- или более слойный персептрон уже невозможно

обучить, руководствуясь только величинами ошибок на выходах

сети

Один из вариантов решения этой проблемы - разработка

наборов выходных сигналов, соответствующих входным, для

каждого слоя нейронной сети, что, конечно, является очень

трудоемкой операцией и не всегда осуществимо Второй вариант -

динамическая подстройка весовых коэффициентов синапсов, в ходе

которой выбираются, как правило, наиболее слабые связи и

изменяются на малую величину в ту или иную сторону, а сохраняются

только те изменения, которые повлекли уменьшение ошибки на

выходе всей сети Очевидно, что данный метод, несмотря на ка-

26

жущуюся простоту, требует громоздких рутинных вычислений И,

наконец, третий, более приемлемый вариант - распространение

сигналов ошибки от выходов нейронной сети к ее входам, в

направлении, обратном прямому распространению сигналов в

обычном режиме работы Этот алгоритм обучения получил название

процедуры обратного распространения ошибки (error back

propagation) Именно он рассматривается ниже

Алгоритм обратного распространения ошибки - это

итеративный градиентный алгоритм обучения, который используется с

целью минимизации среднеквадратичного отклонения текущих от

требуемых выходов многослойных нейронных сетей с

последовательными связями

Согласно методу наименьших квадратов, минимизируемой

целевой функцией ошибки нейронной сети является величина

E(w) = — Ytiyffl-dj kf, (1 9)

2 j k

где yj^ - реальное выходное состояние нейрона у выходного слоя

нейронной сети при подаче на ее входы /с-го образа, dJk -

требуемое выходное состояние этого нейрона

Суммирование ведется по всем нейронам выходного слоя и

по всем обрабатываемым сетью образам Минимизация методом

градиентного спуска обеспечивает подстройку весовых

коэффициентов следующим образом

-f?^-. (1 Ю)

где w(J- весовой коэффициент синаптической связи, соединяющей

/-и нейрон слоя (q-1) су-м нейроном слоя с/, г\- коэффициент

скорости обучения, 0 < г/ <1

В соответствии с правилом дифференцирования сложной

функции

JL = JL^L^Lt (111)

au ^ ds au

где Sj - взвешенная сумма входных сигналов нейрона у, т е

аргумент активационной функции Так как производная активационной

функции должна быть определена на всей оси абсцисс, то

функция единичного скачка и прочие активационные функции с неодно-

родностями не подходят для рассматриваемых нейронных сетей

В них применяются такие гладкие функции, как гиперболический

тангенс или классический сигмоид с экспонентой (см табл 1 1)

Например, в случае гиперболического тангенса

27

^^-s2. (1.12)

ds

Третий множитель ds/dwfJ равен выходу нейрона предыдущего

слоя у,(<Н).

Что касается первого множителя в (1.11), он легко

раскладывается следующим образом:

fe_ ^Е dy^^_ fe_ dy^_ (Q+1)

Здесь суммирование по г выполняется среди нейронов слоя (д+1).

Введя новую переменную:

^^L, (1.14)

&j j

получим рекурсивную формулу для расчетов величин 8}q) слоя q из

величин <5((<7+1) более старшего слоя (q+1)"

}^ (115)

г J uS;

Для выходного слоя:

Теперь можно записать (1.10) в раскрытом виде:

Ди,(*> =-7^> у^-1>. (1.17)

Иногда для придания процессу коррекции весов некоторой

инерционности, сглаживающей резкие скачки при перемещении по

поверхности целевой функции, (1.17) дополняется значением

изменения веса на предыдущей итерации.

AwfHt) = -r,(MAwM(t-l) + V-M)Sf у\ч-Ъ), (1.18)

где //- коэффициент инерционности; f- номер текущей итерации.

Таким образом, полный алгоритм обучения нейронной сети с

помощью процедуры обратного распространения строится

следующим образом.

ШАГ 1. Подать на входы сети один из возможных образов и в

режиме обычного функционирования нейронной сети, когда

сигналы распространяются от входов к выходам, рассчитать значения

последних. Напомним, что:

s<*> = 1у,<*-Х*> , (1.19)

J /=0

28

где L - число нейронов в слое (q-1) с учетом нейрона с

постоянным выходным состоянием +1, задающего смещение; y,(*"1)w/y(<3f) -

/-й вход нейрона у слоя д,

У!ф = f(Sjiq\ (1.20)

где f( •) - сигмоид,

Уг{0) = хп (1.21)

где хг- г-я компонента вектора входного образа.

ШАГ 2. Рассчитать ^Q) для выходного слоя по формуле

(1.16)

Рассчитать по формуле (1.17) или (1.18) изменения весов

ди/0) слоя Q.

ШАГ 3. Рассчитать по формулам (1.15) и (1.17) (или (1.15) и

(1 18)) соответственно dq) и Л\л/0) для всех остальных слоев,

ШАГ 4. Скорректировать все веса в нейронной сети:

w^)(0 = wfJ<7)(f-1) + Aw^)(f). (1.22)

ШАГ 5. Если ошибка сети существенна, перейти на шаг 1. В

противном случае - конец.

Сети на шаге 1 попеременно в случайном порядке

предъявляются все тренировочные образы, чтобы сеть, образно говоря, не

забывала одни по мере запоминания других.

Из выражения (1.17) следует, что когда выходное значение

у,(сН) стремится к нулю, эффективность обучения заметно

снижается. При двоичных входных векторах в среднем половина

весовых коэффициентов не будет корректироваться, поэтому область

возможных значений выходов нейронов (0, 1) желательно сдвинуть

в пределы (-0,5, 0,5), что достигается простыми модификациями

логистических функций. Например, сигмоид с экспонентой

преобразуется к виду:

-0,5 + 1—. (1.23)

1 "as

Рассмотрим вопрос о емкости нейронной сети, т. е. числа

образов, предъявляемых на ее входы, которые она способна

научиться распознавать. Для сетей с числом слоев больше двух, этот

вопрос остается открытым. Для сетей с двумя слоями,

детерминистская емкость сети Cd оценивается следующим образом:

^<С*<^1од(Ц, (124)

т тут)

где Lw - число подстраиваемых весов, т - число нейронов в

выходном слое.

29

Данное выражение получено с учетом некоторых

ограничений. Во-первых, число входов п и нейронов в скрытом слое L

должно удовлетворять неравенству (п+L) > т. Во-вторых, LJm >

1000. Однако приведенная оценка выполнена для сетей с

пороговыми активационными функциями нейронов, а емкость сетей с

гладкими активационными функциями, например (1.23), обычно

больше. Кроме того, термин детерминистский означает, что

полученная оценка емкости подходит для всех входных образов,

которые могут быть представлены п входами. В действительности

распределение входных образов, как правило, обладает некоторой

регулярностью, что позволяет нейронной сети проводить

обобщение и, таким образом, увеличивать реальную емкость. Так как

распределение образов, в общем случае, заранее не известно, можно

говорить о реальной емкости только предположительно, но обычно

она раза в два превышает детерминистскую емкость.

Вопрос о емкости нейронной сети тесно связан с вопросом о

требуемой мощности выходного слоя сети, выполняющего

окончательную классификацию образов. Например, для разделения

множества входных образов по двум классам достаточно одного

выходного нейрона. При этом каждый логический уровень («1» и «0»)

будет обозначать отдельный класс. На двух выходных нейронах с

пороговой функцией активации можно закодировать уже четыре

класса. Для повышения достоверности классификации желательно

ввести избыточность путем выделения каждому классу одного

нейрона в выходном слое или, что еще лучше, нескольких, каждый

из которых обучается определять принадлежность образа к классу

со своей степенью достоверности, например: высокой, средней и

низкой. Такие нейронные сети позволяют проводить

классификацию входных образов, объединенных в нечеткие (размытые или

пересекающиеся) множества. Это свойство приближает подобные

сети к реальным условиям функционирования биологических

нейронных сетей.

Рассматриваемая нейронная сеть имеет несколько «узких

мест». Во-первых, в процессе большие положительные или

отрицательные значения весов могут сместить рабочую точку на сиг-

моидах нейронов в область насыщения. Малые величины

производной от логистической функции приведут в соответствии с (1.15)

и (1.16) к остановке обучения, что парализует сеть. Во-вторых,

применение метода градиентного спуска не гарантирует

нахождения глобального минимума целевой функции. Это тесно связано

вопросом выбора скорости обучения. Приращения весов и,

следовательно, скорость обучения для нахождения экстремума должны

быть бесконечно малыми, однако в этом случае обучение будет

30

происходить неприемлемо медленно. С другой стороны, слишком

большие коррекции весов могут привести к постоянной

неустойчивости процесса обучения. Поэтому в качестве коэффициента

скорости обучения т] обычно выбирается число меньше 1 (например,

0,1), которое постепенно уменьшается в процессе обучения. Кроме

того, для исключения случайных попаданий сети в локальные

минимумы иногда, после стабилизации значений весовых

коэффициентов, т] кратковременно значительно увеличивают, чтобы начать

градиентный спуск из новой точки. Если повторение этой

процедуры несколько раз приведет сеть в одно и то же состояние, можно

предположить, что найден глобальный минимум.

Существует другой метод исключения локальных минимумов

и паралича сети, заключающийся в применении стохастических

нейронных сетей.

Дадим изложенному геометрическую интерпретацию.

В алгоритме обратного распространения вычисляется вектор

градиента поверхности ошибок. Этот вектор указывает

направление кратчайшего спуска по поверхности из текущей точки,

движение по которому приводит к уменьшению ошибки.

Последовательность уменьшающихся шагов приведет к минимуму того или иного

типа. Трудность здесь представляет вопрос подбора длины шагов.

При большой величине шага сходимость будет более

быстрой, но имеется опасность перепрыгнуть через решение или в

случае сложной формы поверхности ошибок уйти в неправильном

направлении, например, продвигаясь по узкому оврагу с крутыми

склонами, прыгая с одной его стороны на другую. Напротив, при

небольшом шаге и верном направлении потребуется очень много

итераций. На практике величина шага берется пропорциональной

крутизне склона, так что алгоритм замедляет ход вблизи

минимума. Правильный выбор скорости обучения зависит от конкретной

задачи и обычно делается опытным путем. Эта константа может

также зависеть от времени, уменьшаясь по мере продвижения

алгоритма.

Обычно этот алгоритм видоизменяется таким образом,

чтобы включать слагаемое импульса (или инерции). Это способствует

продвижению в фиксированном направлении, поэтому, если было

сделано несколько шагов в одном и том же направлении, то

алгоритм увеличивает скорость, что иногда позволяет избежать

локального минимума, а также быстрее проходить плоские участки.

На каждом шаге алгоритма на вход сети поочередно

подаются все обучающие примеры, реальные выходные значения сети

сравниваются с требуемыми значениями, и вычисляется ошибка.

Значение ошибки, а также градиента поверхности ошибок исполь-

31

зуется для корректировки весов, после чего все действия

повторяются. Процесс обучения прекращается либо когда пройдено

определенное количество эпох, либо когда ошибка достигнет

некоторого определенного малого уровня, либо когда ошибка перестанет

уменьшаться.

Рассмотрим проблемы обобщения и переобучения

нейронной сети более подробно. Обобщение - это способность

нейронной сети делать точный прогноз на данных, не принадлежащих

исходному обучающему множеству. Переобучение же

представляет собой чрезмерно точную подгонку, которая имеет место, если

алгоритм обучения работает слишком долго, а сеть слишком

сложна для такой задачи или для имеющегося объема данных.

Продемонстрируем проблемы обобщения и переобучения на

примере аппроксимации некоторой зависимости не нейронной

сетью, а посредством полиномов, при этом суть явления будет

абсолютно та же.

Графики полиномов могут иметь различную форму, причем,

чем выше степень и число членов, тем более сложной может быть

эта форма. Для исходных данных можно подобрать

полиномиальную кривую (модель) и получить, таким образом, объяснение

имеющейся зависимости. Данные могут быть зашумлены, поэтому

нельзя считать, что лучшая модель в точности проходит через все

имеющиеся точки. Полином низкого порядка может лучше

объяснять имеющуюся зависимость, однако, быть недостаточно гибким

средством для аппроксимации данных, в то время как полином

высокого порядка может оказаться чересчур гибким, но будет точно

следовать данным, принимая при этом замысловатую форму, не

имеющую никакого отношения к настоящей зависимости.

Нейронные сети сталкивается с такими же трудностями.

Сети с большим числом весов моделируют более сложные функции

и, следовательно, склонны к переобучению. Сети же с небольшим

числом весов могут оказаться недостаточно гибкими, чтобы

смоделировать имеющиеся зависимости. Например, сеть без скрытых

слоев моделирует лишь обычную линейную функцию.

Как же выбрать правильную степень сложности сети? Почти

всегда более сложная сеть дает меньшую ошибку, но это может

свидетельствовать не о хорошем качестве модели, а о

переобучении сети.

Выход состоит в использовании контрольной

кросс-проверки. Для этого резервируется часть обучающей выборки, которая

используется не для обучения сети по алгоритму обратного

распространения ошибки, а для независимого контроля результата в

ходе алгоритма. В начале работы ошибка сети на обучающем и

32

контрольном множествах будет одинаковой. По мере обучения

сети ошибка обучения убывает, как и ошибка на контрольном

множестве. Если же контрольная ошибка перестала убывать или даже

стала расти, это указывает на то, что сеть начала слишком близко

аппроксимировать данные (переобучилась) и обучение следует

остановить. Если это случилось, то следует уменьшить число

скрытых элементов и/или слоев, ибо сеть является слишком

мощной для данной задачи. Если же обе ошибки (обучения и кросс-

проверки) не достигнут достаточного малого уровня, то

переобучения, естественно не произошло, а сеть, напротив, является

недостаточно мощной для моделирования имеющейся зависимости.

Описанные проблемы приводят к тому, что при практической

работе с нейронными сетями приходится экспериментировать с

большим числом различных сетей, порой обучая каждую из них по

несколько раз и сравнивая полученные результаты. Главным

показателем качества результата является здесь контрольная ошибка.

При этом, в соответствии с общесистемным принципом, из двух

сетей с приблизительно равными ошибками контроля имеет смысл

выбрать ту, которая проще.

Необходимость многократных экспериментов приводит к

тому, что контрольное множество начинает играть ключевую роль в

выборе модели и становится частью процесса обучения. Тем

самым ослабляется его роль как независимого критерия качества

модели. При большом числе экспериментов есть большая

вероятность выбрать удачную сеть, дающую хороший результат на

контрольном множестве. Однако для того чтобы придать

окончательной модели должную надежность, часто (когда объем обучающих

примеров это позволяет) поступают следующим образом:

резервируют тестовое множество примеров. Итоговая модель

тестируется на данных из этого множества, чтобы убедиться, что

результаты, достигнутые на обучающем и контрольном множествах

примеров, реальны, а не являются артефактами процесса обучения.

Разумеется, для того чтобы хорошо играть свою роль, тестовое

множество должно быть использовано только один раз: если его

использовать повторно для корректировки процесса обучения, то

оно фактически превратится в контрольное множество.

С целью ускорения процесса обучения сети предложены

многочисленные модификации алгоритма обратного

распространения ошибки, связанные с использованием различных функций

ошибки, процедур определения направления и величин шага.

1) Функции ошибки:

• интегральные функции ошибки по всей совокупности

обучающих примеров;

33

• функции ошибки целых и дробных степеней

2) Процедуры определения величины шага на каждой

итерации

• дихотомия;

• инерционные соотношения (см выше);

• отжиг.

3) Процедуры определения направления шага:

• с использованием матрицы производных второго порядка

(метод Ньютона);

• с использованием направлений на нескольких шагах

(партан метод).

1.4.2. Обучение без учителя

Рассмотренный алгоритм обратного распространения

ошибки подразумевает наличие некоего внешнего звена,

предоставляющего нейронной сети, кроме входных, целевые выходные

образы. Алгоритмы, основанные на подобной концепции, называются

алгоритмами обучения с учителем. Для их успешного

функционирования необходимо наличие экспертов, задающих на

предварительном этапе для каждого входного образа эталонный выходной.

Так как создание интеллектуальных систем базируется, во многом,

на биологических прототипах, до сих пор не прекращается спор о

том, можно ли считать алгоритмы обучения с учителем

натуральными или же они полностью искусственны. Например, обучение

человеческого мозга, на первый взгляд, происходит без учителя:

на зрительные, слуховые, тактильные и прочие рецепторы

поступает информация извне, и внутри нервной системы происходит

некая самоорганизация. Однако, нельзя отрицать и того, что в

жизни человека немало учителей (и в буквальном, и в переносном

смысле), которые координируют внешние воздействия. Вместе в

тем, чем бы ни закончился спор приверженцев этих концепций

обучения, они обе имеют право на существование.

Главная черта, делающая обучение без учителя

привлекательным, это его самостоятельность. Процесс обучения, как и в

случае обучения с учителем, заключается в подстраивании весов

синапсов. Некоторые алгоритмы, правда, изменяют и структуру

сети, т. е. количество нейронов и их взаимосвязи, но такие

преобразования правильнее назвать более широким термином -

самоорганизацией. Очевидно, что подстройка весов синапсов может

проводиться только на основании информации о состоянии

нейронов и уже имеющихся весовых коэффициентов). На этом, в част-

34

иости, по аналогии с известными принципами самоорганизации

нервных клеток, построены алгоритмы обучения Хебба.

Сигнальный метод обучения Хебба заключается в

изменении весов по следующему правилу.

wIJ(t) = wIJ(t-V + ayi;q^y{Jq\ (125)

где у,(сН) - выходное значение нейрона /слоя (g-1), y}q) - выходное

значение нейрона у слоя g; wtJ(t) и w,y{M) - весовой коэффициент

синапса, соединяющего эти нейроны, на итерациях t и (М)

соответственно; а - коэффициент скорости обучения. Здесь и далее,

для общности, под g подразумевается произвольный слой сети.

При обучении по данному методу усиливаются связи между

возбужденными нейронами.

Существует также и дифференциальный метод обучения

Хебба, определяемый соотношением:

wff (0 = wa(f -1) + а (к^СО - y,(Q"1)(f -1))- (к?}(0 - y5Q)(f - 1))-d -26)

Здесь y(cH)(f) и у,(сН)(М) - выходное значение нейрона / слоя

(g-1) соответственно на итерациях t и (М); y}q\f) и уу((7)(М) - то же

самое для нейрона у слоя д. Как видно из формулы (1.26), более

интенсивно обучаются синапсы, соединяющие нейроны, выходы

которых наиболее динамично изменились в сторону увеличения.

Полный алгоритм обучения с применением

вышеприведенных формул будет выглядеть следующим образом.

ШАГ 1. На стадии инициализации всем весовым

коэффициентам присваиваются небольшие случайные значения.

ШАГ 2. На входы сети подается входной образ, и сигналы

возбуждения распространяются по всем слоям согласно

принципам классических сетей прямого распространения (feedforward).

При этом для каждого нейрона рассчитывается взвешенная сумма

его входов, к которой затем применяется активационная функция

нейрона, в результате чего получается его выходное значение у,((7),

/ = 1.../_ф где Lq - число нейронов в слое g, q = 1...Q, Q - число

слоев в сети

ШАГ 3 На основании полученных выходных значений

нейронов по формуле (1.25) или (1 26) проводится изменение весовых

коэффициентов.

ШАГ 4. Цикл с шага 2, пока выходные значения сети не

стабилизируются с заданной точностью. Применение этого способа

определения момента завершения обучения, отличного от

использовавшегося для сети обратного распространения, обусловлено

тем, что подстраиваемые значения синапсов фактически не огра-

35

ничены. На шаге 2 цикла попеременно предъявляются все образы

из входного набора.

Следует отметить, что вид откликов на каждый класс

входных образов заранее неизвестен и представляет собой

произвольное сочетание состояний нейронов выходного слоя,

обусловленное случайным распределением весов на стадии инициализации.

Вместе с тем, сеть способна обобщать схожие образы, относя их к

одному классу. Тестирование обученной сети позволяет

определить топологию классов в выходном слое. Для приведения

откликов обученной сети к удобному представлению можно дополнить

сеть одним слоем, который, например, по алгоритму обучения

однослойного персептрона необходимо заставить отображать

выходные реакции сети в требуемые образы.

Другой алгоритм обучения без учителя - алгоритм Кохоне

на - предусматривает подстройку синапсов на основании их

значений на предыдущей итерации:

Из выражения (1.27) видно, что обучение сводится к

минимизации разницы между входными сигналами нейрона,

поступающими с выходов нейронов предыдущего слоя у,((Н), и весовыми

коэффициентами его синапсов.

Полный алгоритм обучения имеет примерно такую же

структуру, как в методах Хебба, но на шаге 3 из всего слоя выбирается

нейрон, значения синапсов которого максимально походят на

входной образ, и подстройка весов по формуле (1.27) проводится

только для него. Эта, так называемая, аккредитация может

сопровождаться торможением всех остальных нейронов слоя и

введением выбранного нейрона в насыщение. Выбор такого нейрона

может осуществляться, например, расчетом скалярного

произведения вектора весовых коэффициентов с вектором входных

значений. Максимальное произведение дает выигравший нейрон.

Другой вариант состоит в расчете расстояния между этими

векторами в R-мерном пространстве:

О, =Jll(y{y-wIJ)2 , (1.28)

где R - размерность векторов; у - индекс нейрона в слое q\ i -

индекс суммирования по нейронам слоя (g-1); wfJ - вес синапса,

соединяющего нейроны; выходы нейронов слоя (Q-1) являются

входными значениями для слоя q.

В данном случае, побеждает нейрон с наименьшим

расстоянием. Иногда слишком часто получающие аккредитацию нейроны

36

принудительно исключаются из рассмотрения, чтобы уравнять

права всех нейронов слоя. Простейший вариант такого алгоритма

заключается в торможении только что выигравшего нейрона.

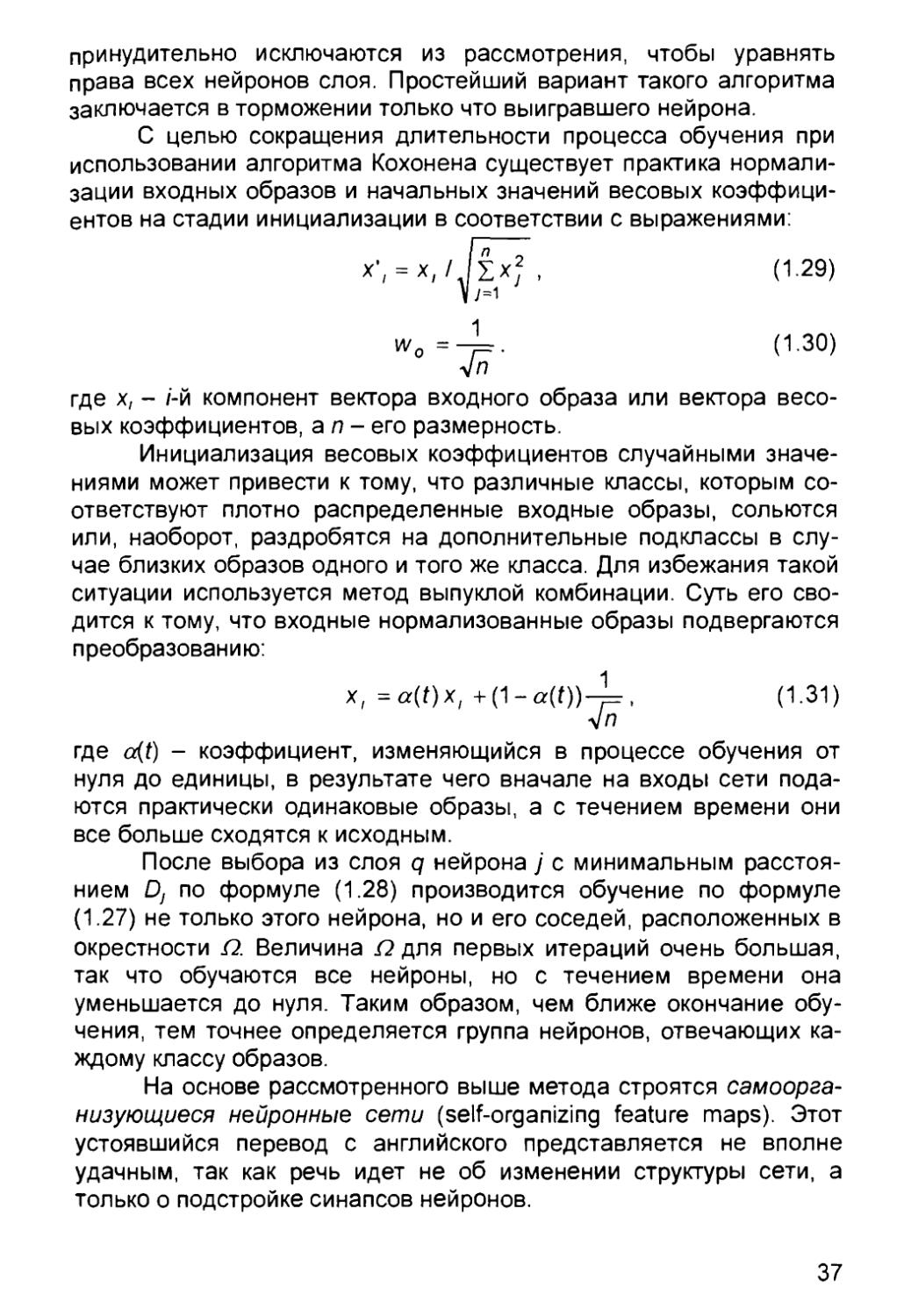

С целью сокращения длительности процесса обучения при

использовании алгоритма Кохонена существует практика

нормализации входных образов и начальных значений весовых

коэффициентов на стадии инициализации в соответствии с выражениями:

у (1.29)

ып

где х, - /-й компонент вектора входного образа или вектора

весовых коэффициентов, an- его размерность.

Инициализация весовых коэффициентов случайными

значениями может привести к тому, что различные классы, которым

соответствуют плотно распределенные входные образы, сольются

или, наоборот, раздробятся на дополнительные подклассы в

случае близких образов одного и того же класса. Для избежания такой

ситуации используется метод выпуклой комбинации. Суть его

сводится к тому, что входные нормализованные образы подвергаются

преобразованию:

где a(t) - коэффициент, изменяющийся в процессе обучения от

нуля до единицы, в результате чего вначале на входы сети

подаются практически одинаковые образы, а с течением времени они

все больше сходятся к исходным.

После выбора из слоя q нейрона у с минимальным

расстоянием Dj по формуле (1.28) производится обучение по формуле

(1.27) не только этого нейрона, но и его соседей, расположенных в

окрестности П. Величина П для первых итераций очень большая,

так что обучаются все нейроны, но с течением времени она

уменьшается до нуля. Таким образом, чем ближе окончание

обучения, тем точнее определяется группа нейронов, отвечающих

каждому классу образов.

На основе рассмотренного выше метода строятся

самоорганизующиеся нейронные сети (self-organizing feature maps). Этот

устоявшийся перевод с английского представляется не вполне

удачным, так как речь идет не об изменении структуры сети, а

только о подстройке синапсов нейронов.

37

1.5. Настройка числа нейронов в скрытых слоях

многослойных нейронных сетей

в процессе обучения

Для того, чтобы многослойная нейронная сеть реализовыва-

ла заданное обучающей выборкой отображение, она должна иметь

достаточное число нейронов в скрытых слоях В настоящее время

нет формул для точного определения необходимого числа

нейронов в сети по заданной обучающей выборке. Однако предложены

способы настройки числа нейронов в процессе обучения, которые

обеспечивают построение нейронной сети для решения задачи и

дают возможность избежать избыточности. Эти способы настройки

можно разделить на две группы алгоритмы сокращения (pruning

algorithms) и конструктивные алгоритмы (constructive algorithms)

1.5.1. Алгоритмы сокращения

В начале работы алгоритма обучения с сокращением число

нейронов в скрытых слоях сети заведомо избыточно. Затем из

нейронной сети постепенно удаляются синапсы и нейроны.

Существуют два подхода к реализации алгоритмов сокращения.

1) Метод штрафных функций.

В целевую функцию алгоритма обучения вводится штрафы

за то, что значения синаптических весов отличны от нуля,

например.

C* (1.32)

где wtJ - синаптический вес, / - номер нейрона, у - номер входа; L -

число нейронов скрытого слоя, п - размерность входного сигнала

2) Метод проекций.

Синаптический вес обнуляется, если его значение попало в

заданный диапазон.

w,=j0' Ml* <133>

[Wij, \Wij\>€,

где а - некоторая константа.

Алгоритмы сокращения имеют, по крайней мере, два

недостатка:

• нет методики определения числа нейронов скрытых

слоев, которое является избыточным, поэтому перед началом работы

алгоритма нужно угадать это число;

38

• в процессе работы алгоритма сеть содержит избыточное

число нейронов, поэтому обучение идет медленно

1.5.2. Конструктивные алгоритмы

Предшественником конструктивных алгоритмов можно

считать методику обучения многослойных нейронных сетей,

включающую в себя следующие шаги:

ШАГ 1. Выбор начального числа нейронов в скрытых слоях.

ШАГ 2 Инициализация сети, заключающаяся в

присваивании синаптическим весам и смещениям сети случайных значений

из заданного диапазона.

ШАГ 3. Обучение сети по заданной выборке.

ШАГ 4 Завершение в случае успешного обучения. Если сеть

обучить не удалось, то число нейронов увеличивается и

повторяются шаги со второго по четвертый.

В конструктивных алгоритмах число нейронов в скрытых

слоях также изначально мало и постепенно увеличивается В

отличие от этой методики, в конструктивных алгоритмах сохраняются

навыки, приобретенные сетью до увеличения числа нейронов.

Конструктивные алгоритмы различаются правилами задания

значений параметров в новых, добавленных в сеть, нейронах:

• значения параметров являются случайными числами из

заданного диапазона;

• значения синаптических весов нового нейрона

определяются путем расщепления (splitting) одного из старых нейронов

Первое правило не требует значительных вычислений,

однако его использование приводит к некоторому увеличению

значения функции ошибки после каждого добавления нового нейрона. В

результате случайного задания значений параметров новых

нейронов может появиться избыточность в числе нейронов скрытого

слоя Расщепление нейронов лишено двух указанных недостатков

Суть алгоритма расщепления проиллюстрирована на рис 1 7

На этом рисунке показан вектор весов нейрона скрытого

слоя на некотором шаге обучения и векторы изменения весов,

соответствующие отдельным обучающим примерам. Векторы

изменений имеют два преимущественных направления и образуют в

пространстве область, существенно отличающуюся от

сферической. Суть алгоритма заключается в выявлении и расщеплении

таких нейронов В результате расщепления вместо одного

исходного в сети оказывается два нейрона. Первый из этих нейронов

имеет вектор весов, представляющий из себя сумму вектора весов

исходного нейрона и векторов изменений весов одного из преиму-

39

Новый

нейрон

№ 1

Векторы

изменений

весов

Вектор весов / V Новый

исходного / нейрон

нейрона / № 2

Рис. 1.7. Вектор весов нейрона скрытого слоя и изменения,

соответствующие отдельным обучающим примерам

щественных направлений. В результате суммирования векторов

изменений весов другого преимущественного направления и

вектора весов исходного нейрона получают синаптические веса

второго нового нейрона.

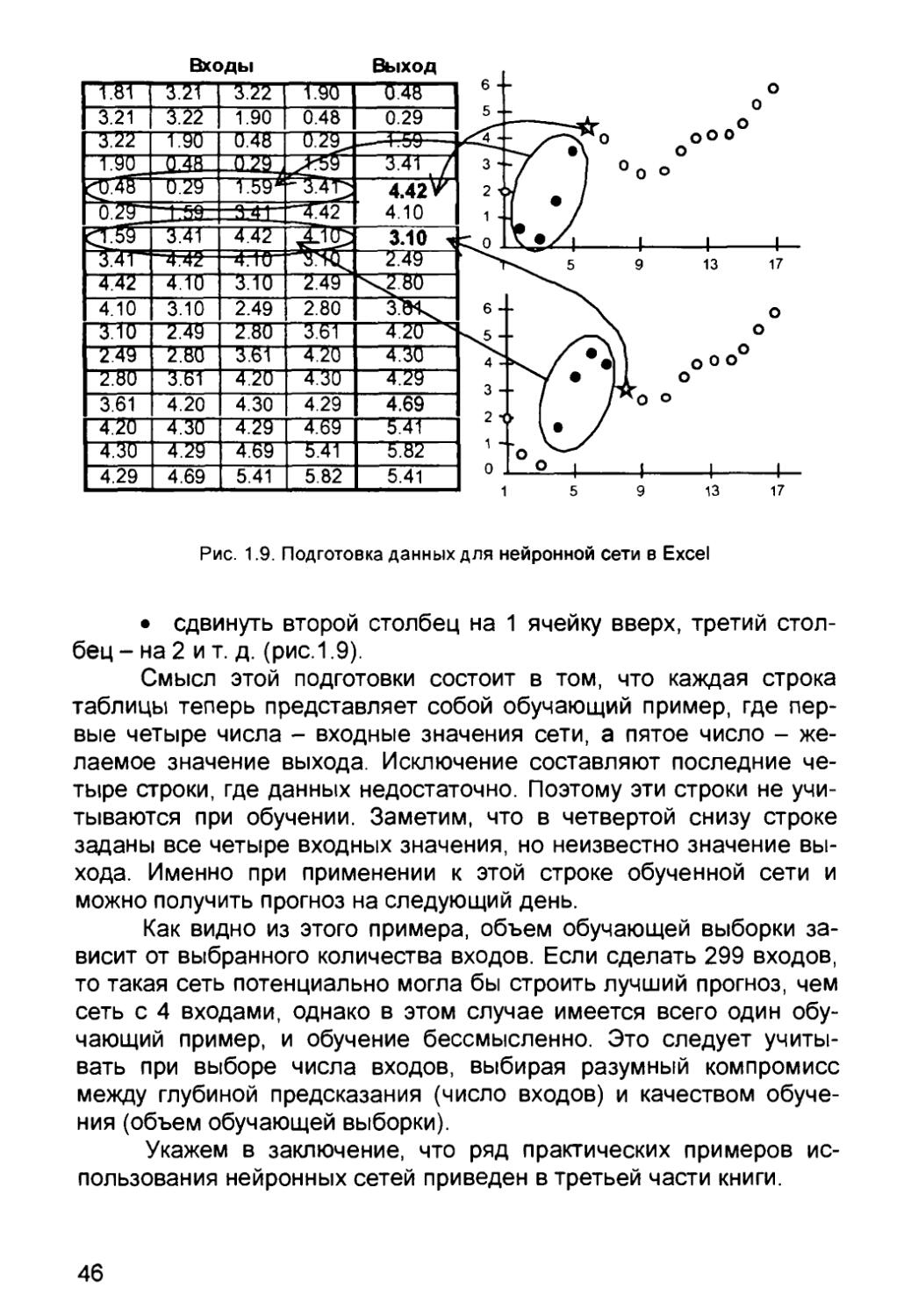

Расщеплять нейроны, векторы изменений которых имеют