Текст

Ф. П. Васильев

Лекции

по методам

решения

экстремальных

задач

Издательство

Московского университета

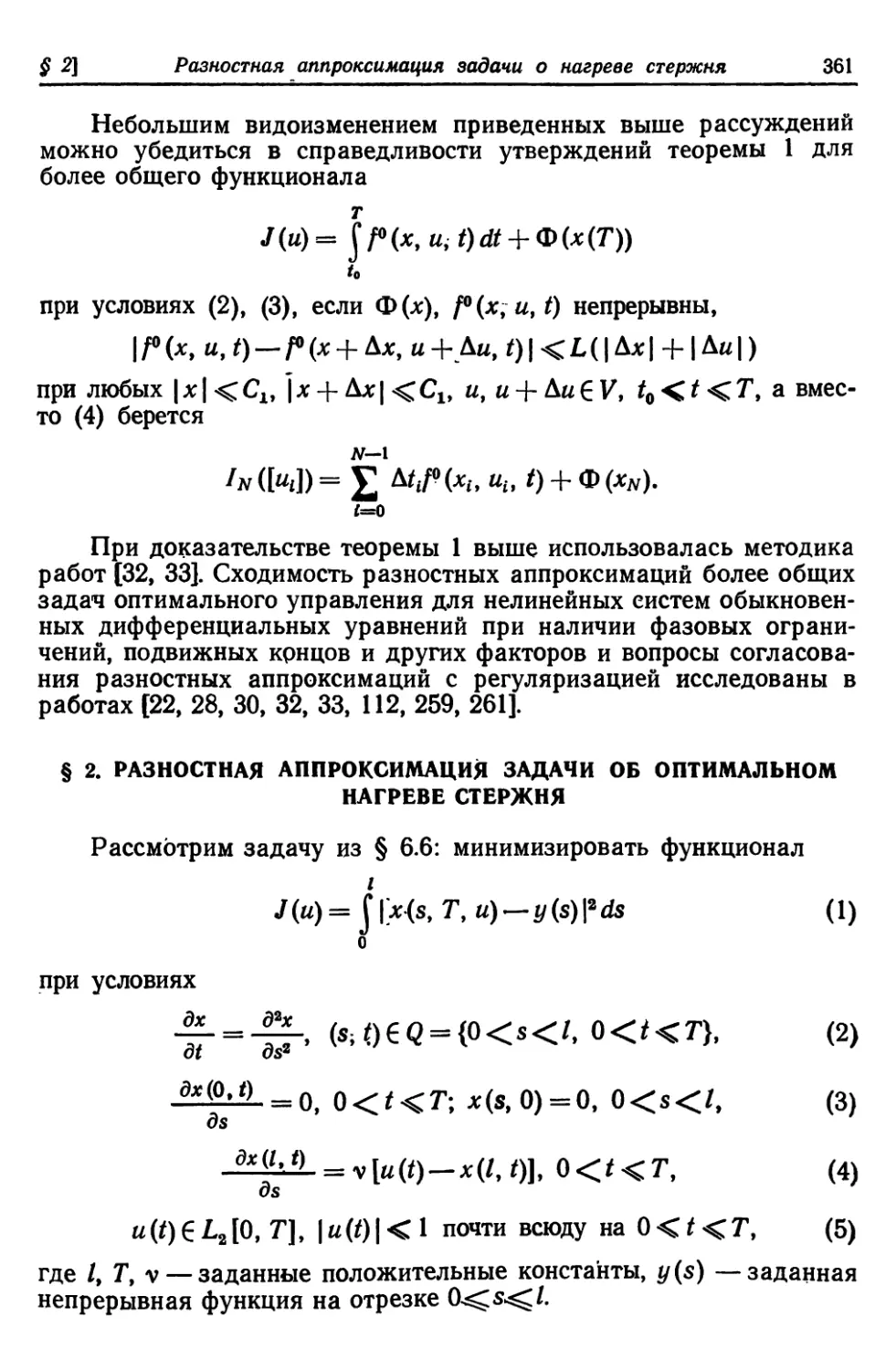

1974

ОГЛАВЛЕНИЕ

Предисловие ........ 5

Глава 1. Минимизация функций одной переменной 7

§ 1. Постановка задачи .'.... 7

§ 2. Задачи А и Б. Строго квазивыпуклые функции .... 8

§ 3. Оптимальный пассивный поиск в задачах А и Б . * . . 11

§ 4. Последовательный поиск 16

§ 5. Метод деления отрезка пополам 18

16. Оптимальный последовательный поиск для задачи А . . . 20

§ 7. Оптимальный последовательный поиск для задачи Б . 27

§ 8. Метод золотого сечения 32

§ 9. Метод ломаных : 35

§ 10. Выпуклые функции. Метод касательных 38

§ И. Метод парабол 44

§ 12. О* некоторых других методах минимизации ..... 47

Глава 2. Минимизация функций многих переменных 51

§ 1. Постановка задачи. Обозначения. Вспомогательные сведения 51

§ 2. Градиентный метод 65

§ 3. Метод проекции градиента 72

§ 4. Метод возможных направлений . 77

§ 5. Метод проекции опорных функций -. 84

§ 6. Метод условного градиента , 96

§ 7. Метод сопряженных градиентов 101

§ 8. Метод Ньютона * 107

§ 9. Метод штрафных функций 117

§ 10. Теорема Куна — Таккера 121

§ 11. Элементы линейного программирования ....... 131

§ 12. О методе случайного поиска и некоторых других методах . 148

Глава 3. Принцип максимума Л. С. Понтрягина 155

§ 1. Постановка задачи оптимального управления . . w » . . 155

§ 2. Формулировка принципа максимума Л. С. Понтрягина . . 159

§ 3. Приближенное решение краевой задачи принципа максимума 168

§ 4. Связь между принципом максимума и классическим вариаци-

онным исчислением 177

Глава 4. Динамическое программирование. Проблема синтеза ... 181

§ 1. Схема Р. Беллмана. Проблема синтеза для дискретных систем 481

§ 2. Схема Н. Н. Моисеева 191

§ 3. Дифференциальное уравнение Р. Беллмана . 198

§ 4. Проблема синтеза для систем с непрерывным временем. Оцен-

ка погрешности 203

Глава 5. Достаточные условия оптимальности 213

§ 1. Достаточные условия оптимальности для задач с закрепленным

временем 213

§ 2. Достаточные условия оптимальности для задач с незакреплен-

ным временем 222

§ 3. Достаточные условия оптимальности для дискретных управляе-

мых систем. Оценка погрешности 227

Глава 6. Методы минимизации в функциональных пространствах 232

§ 1. Вспомогательные сведения 233

§ 2. Некоторые методы минимизации функционалов . ... 247

§ 3. Задача оптимального управления со свободным правым концом 257

§ 4. Градиент функционала, связанного с дискретной управляемой

системой. Условия оптимальности . .' 27>

§ 5. Минимизация квадратичного функционала. Примеры . . . 284

§ 6. Оптимальное управление процессом нагрева стержня . . 294

§ 7. Оптимальное управление процессом колебания струны . . ЗОО

Глава 7. Методы решения задач быстродействия 308

§ 1. Постановка задачи 308-

§ 2. Вспомогательный аппарат. Критерии управляемости и опти-

мальности 314

§ 3. р-метод 321

§ 4. Приложения 327"

Глава 8. Регуляризация некорректно поставленных экстремальных задач 337

§ 1. О некорректно поставленных задачах минимизации . 337

§ 2. Метод регуляризации А. Н. Тихонова 339»

§ 3. Регуляризация при вычислении с погрешностями .... 349-

§ 4. Регуляризация с помощью аппроксимации множества 351

§ 5. Усиленная регуляризация * 353»

Глава 9. Разностные аппроксимации задач оптимального управления 35S

§ 1. Разностная аппроксимация для одной задачи минимизации

квадратичного функционала 355=

§ 2. Разностная аппроксимация задачи об оптимальном нагреве

стержня 361'

Литература . . 364

Предисловие

В последние десятилетия весьма актуальными стали вопросы наилучшего

(в том или ином смысле) управления различными процессами физики,

техники, экономики и др. Сюда относится, например, задача огранизации

производства с целью получения максимальной прибыли при заданных

затратах ресурсов; задача управления системой гидростанций и водо-

хранилищ с целью получения максимального количества электроэнергии;

задача о космическом перелете из одной точки пространства в другую

наибыстрейшим образом или с наименьшей затратой энергии; задача о

быстрейшем нагреве печи до заданного температурного режима и многие

другие задачи. К таким проблемам приводят также многие задачи вычис-

лительной математики, как, например, задача наилучшего приближения

функций, задача минимизации невязки уравнения и др.

В математической постановке задачи сводятся к отысканию экстре-

мума (максимума или минимума) некоторой функции или функционала

J (и), выражающего собой качество (цену) управления и из заданного

множества V некоторого пространства. Требование принадлежности

управления и некоторому множеству V выражает собой- ограничения,

обычно вытекающие из ограниченности наличных ресурсов, возможностей

технической реализации управления, нежелательности каких-либо запре-

щенных (аварийных) состояний и т. п. Задачи отыскания экстремума

функционала J (и) на множестве U принято называть экстремальными за-

дачами. Заметим, что задача максимизации функционала J (и) на множе-

стве U эквивалентна задаче минимизации функционала —Пи) на том же

множестве U, поэтому можно ограничиться рассмотрением задач мини-

мизации.

С 50-х годов теория экстремальных задач обогатилась фундамен-

тальными результатами, потребности практики способствовали бурному

развитию методов приближенного решения экстремальных задач.

В основу настоящей книги положен курс лекций по численным мето-

дам решения экстремальных задач, который автор в течение ряда лет чи-

тает студентам 3—4-го курса факультета вычислительной математики и

кибернетики Московского университета. В книге изложены основы наи-

более часто используемых на практике методов приближенного решения

экстремальных задач, теоретическое обоснование и краткая характеристи-

ка этих методов. Содержание книги можно разделить на две части.

К первой относятся две первые главы, где рассматриваются методы мини-

мизации функций конечного числа переменных, во второй части — методы

минимизации функционалов, заданных на множествах из функциональных

(в основном гильбертовых) пространств и связанных с процессами, опи-

сываемыми системами обыкновенных дифференциальных уравнений или

уравнениями с частными производными.

Заманчиво было изложить методы минимизации в общем виде на

языке функционального анализа в первой же части лекций, охватив при

этом как частный случай многие методы минимизации функций конечного

числа переменных и различных других классов функционалов. Однако

такой способ изложения, несмотря на свою привлекательность и удобства

для читателя-знатока, видимо, все же труден для первого знакомства с

предметом, не говоря уже о том, что он не может отразить всю специфику

конечномерных задач.

Таким образом, принятое в книге расположение материала объяс-

няется стремлением автора, с одной стороны, сделать книгу, доступной

читателям, владеющим математикой в объеме программ технических вузов

и желающим впервые ознакомиться с теорией и методами решения экстре-

мальных задач, с другой стороны, сохранить математическую строгость

изложения. По этой причине материал, требующий для своего полного

усвоения знаний элементов функционального анализа, излагается в более

поздних главах книги. Заметим, впрочем, что отсутствие знаний по функ-

циональному анализу не будет мешать пониманию и усвоению излагае-

мых в этих главах основ методов и иллюстрирующих их конкретных .при-

меров экстремальных задач, если только читатель будет готов некоторые

утверждения принять не в их максимально общей форме.

Многие параграфы завершаются упражнениями, помогающими усво-

ить содержание основного текста и дополняющими его. Объем книги

заставил автора ограничиться лишь / небольшим количеством примеров

экстремальных задач, иллюстрирующих описываемые в книге методы.

Список.литературы, приводимый в конце книги,-никак не может претен-

довать на библиографическую полноту и не имеет целью отразить исто-

рические аспекты и чей-либо приоритет в рассматриваемых вопросах, а

содержит лишь те работы, которые были непосредственно использованы

в книге или близко примыкают к ней, дополняя ее содержание.

Нумерация формул, теорем, лемм, определений, упражнений в каж-

дом параграфе самостоятельная; ссылки на материалы, расположенные в

пределах данного параграфа, имеют вид (А), вне данного параграфа, но

в пределах данной главы — (В. А) вне данной главы — (С. В. А), где

С — номер главы, В — номер параграфа, в котором находится упоми-

наемая формула, теорема или другой материал с номером А. Так, напри-

мер, теорема 3 из §*1 главы 2 в пределах данного § 1 именуется просто

теоремой 3, в других параграфах 2-й главы — теоремой 1.3, в других

главах — теоремой 2.1.3. Аналогично, при ссылках на § В главы С в

пределах главы С .этот параграф будет именоваться просто § В, вне гла-

вы С — § С. А. Значок А в тексте означает окончание доказательства

теорем, лемм.

Автор выражает глубокую благодарность академику А. Н. Тихонову

за внимание и поддержку при написании книги, В. Г. Карманову,

М. С. Никольскому, Н. X. Розову, прочитавшим книгу в рукописи и сде-

лавшим ряд ценных замечаний, И. С. Березину, взявшему на себя труд

по научному редактированию книги и своими советами способствовавшему

улучшению содержания книги, устранившему многочисленные погрешности

изложения. Автор весьма признателен В. Г. Курилову, В. И. Селиверсто-

вой, А. С. Стрекаловскому за большую помощь в подготовке рукописи

к изданию.

Автор будет благодарен читателям за все замечания по содержа-

нию книги.

Глава 1

Минимизация функций одной переменной

§ 1. ПОСТАНОВКА ЗАДАЧИ

•

Пусть на множестве U={u: a^u^.b} числовой оси, где а и

Ь — заданные числа, —оо^а<6^|+оо, определена функция

J (и). Под задачей минимизации функции J (и) на множестве U

будем понимать следующее: 1) найти «/*= inf J (и); 2) если на U.

нижняя грань достигается, то найти точку ы*е£/, в которой

J(u*)=J*\ 3) если нижняя грань не достигается на £/, то указать

последовательность ы0, ии ...; и*, ...; Uh^U (&=0, il, ...) такую, что

Пт,/(иЛ) = /\ Точку u*^U со свойством /(«*)=/* называют тон-

fe-»oo

кой минимума J (и) на £/, а последовательность {Uk}^U со свой-

ством: limJ(uk)= J* называют минимизирующей последователь-

Л-юо

ностью для функции J (и) на U.

Что нам известно из классического математического анализа о

методах решения этой задачи? Допустим, что J (и) кусочно-непре-

рывная и кусочно-гладкая функция на U. Тогда, как известно [126],

минимум J (и) на U может достигаться лишь в тех точках wet/, в

которых или //(а)=0, или У'(и) не существует, или J (и) терпит

разрыв, или же, в точках, являющихся граничными для множества

V. Такие точки принято называть точками, подозрительными на

минимум. Если точки, подозрительные на минимум, найдены, то

среди них нужно выбрать те, в которых, в самом деле достигается

минимум. Для этого обычно исследуется знак производной J'(u)

в окрестности подозрительной точки или знак второй производной

J"(u) в этой точке, если J"(u) существует. В результате такого

отбора определяются точки, в которых достигается, вообще говоря,

лишь локальный минимум J (и) на U. Чтобы найти абсолютный

минимум J (и) на £/, остается перебрать все точки локального ми-

нимума и из них выбрать точку с наименьшим значением функции,

если таковая существует.

Описанным способом поиска минимума можно воспользовать-

ся во всех тех случаях, когда функции и ее производные имеют

достаточно простой вид, и без особых трудностей удается реали-

7

8 МИНИМИЗАЦИЯ ФУНКЦИИ ОДНОЙ ПЕРЕМЕННОЙ [Гл. I

зовать указанную выше схему отбора точки абсолютного миниму-

ма. К сожалению, этот подход лишь в редких случаях позволяет

решить задачу минимизации функции J (и) на С/. Дело р том, что

вычисление производной J (и) в практических задачах зачастую

представляет большие трудности и нередко даже неизвестно, су-

ществует ли производная в интересующей нас точке. Возможно,

например, функция J (и) задана лишь таблично или лишь извест-

но, что в любой точке ие U значение J (и) может быть вычислено

с нужной точностью, а сама- функция задана неявно. В тех слу-

чаях, когда производная все же явно вычислена, решение уравне-

ния J'(u) =0 может встретить серьезные трудности.

Поэтому важно иметь методы минимизации, не требующие вы-

числения производной и основанные лишь на вычислении значений

функции в каких-либо специально подбираемых точках. В прак-

тических задачах вычисление значений функции также может ока-

заться весьма трудоемким делом, и здесь большую ценность приоб-

ретают методы, позволяющие решить задачу минимизации с тре-

буемой точностью на основе вычислений значений функции в воз-

можно меньшем количестве точек.

§ 2. ЗАДАЧИ А И Б. СТРОГО КВАЗИВЫПУКЛЫЕ ФУНКЦИИ

Прежде чем переходить к изложению методов минимизации

функций одной переменной уточним постановку задачи.

Пусть функция J (и) определена на отрезке [a, b]={u:a^Z

^u^b} и достигает на [а, Ь] своей нижней грани, и пусть тре-

буется минимизировать ее на [а, Ь]. В зависимости от того, инте-

ресует ли нас только точка минимума и*, или же наряду с и* мы

интересуемся еще и значением /(w*), следует различат*» две по-

становки задачи минимизации [56]:

Задана А: Найти точку и*е[а, Ь] и значение

/(<0= inf J{u) = J\

Задача Б: Найти точку #*е[а,&], в которой /(«*)=/* (не

интересуясь самим значением /(а*)).

Для приближенного решения этих задач обычно поступают

следующим образом: 1) вычисляют значения функции в каких-либо

специальным образом подбираемых п точках щ, щ, ..., ип из от-

резка [а, 6]; 2) перебором значений J(Ui) среди точек {щ} (i=

= 1, ..., п) выделяют точку йПу в которой J (ип) = min J (щ);

3) из точек а, 6, и\у ..., ип определяют точку ап, ближайшую к

ип слева, и точку ЬПу ближайшую к ип справа; 4) в качестве и*

принимают какую-либо точку ип из отрезка [аПу Ьп]. При реше-

нии задачи А часто полагают un = ип (с вычисленным'значением

§ 2] Задачи А и Б. Строго квазивыпуклые функции 9

J(un))', в задаче Б можно, например, взять #*=—(ап+Ьп) (зна-

чение J(u„) здесь нас не интересует).

Понятно, что такой порядок действий имеет смысл лишь в тех

случаях, когда у нас есть основание считать, что и*е(ап, Ьп]. Од-

нако нетрудно подобрать функцию (даже непрерывную), для ко-

торой и*£[ап> Ьп]. Укажем один важный класс функций, для ко-

торых всегда и*^[ап> Ьп\

Определение 1. Функция J (и), определенная на множестве

U={u : а^:и^Ь}9 называется строго квазивыпуклой на Г/, если

существуют числа а, Р, а^а^р^&, такие, что: 1) J(u) строго

монотонно убывает при а^и<.а (если а<а^'р^6); 2) J (и)

строго монотонно возрастает при р<и^& 1(если a^a^ip<6);

3) J(u)=J* = \nU(u) при а<и<Ср (если а^а<р^6); 4) в точ-

иеи

ках и=а и и=р выполняются условия:/(а)^/*приа=а^р^^;

У (а — 0) = lim J(u)>J(a)>r при а<а<р<6; /(&)>/* при

и-мх—О

a^a^^=b; J ф + 0)= Vim J(u)> J ф)>Г при а<а<р<6; и

наконец, в случае а<а=Р<& :/*^/(a)^max{/(a—0), 7(a+0}

(эквивалентное и более изящное определение см. ниже в упраж-

нении 3) [135].

Множество всех строго квазивыпуклых функций на отрезке

а^и^Ь обозначим через Q[a9 b]. Вот примеры таких функций:

Ji(u)=u2^Q[a> b] при любых a, b; J2(u) = \и\ +a+sign(и)^Q[a,b]

при любых a, b\ Jz(u)= V '' ^ I принадлежит Q[a, Ь] при

" J— 1, w = 0J

любых a, ft. Функция

/*(«) = )'"'' uut°o}eQ[0'1]> но ^l"1* П.

Очевидно, строго квазивыпуклая функция на U локальных ми-

нимумов не имеет, или, точнее говоря, любая точка локального

минимума такой функции одновременно является точкой ее ((абсо-

лютного) минимума на U. Если а<р, то нижняя грань J (и) на U

всегда достигается; если <х=р, то нижняя грань может и не до-

стигаться'. Множество всех тех функций из Q[at 6], которые до-

стигают своей нижней грани на [а, 6], хотя бы в одной точке а*,

обозначим через Q*[a, 6].

Задачи А и Б мы будем рассматривать на классе функций

Q*[at &], 0<&—а<оо. Для функций этого класса, очевидиц спра-

ведливо утверждение: если J(un) ^min{/(an), J(bn)}t an<.un<bn>

то на отрезке [ant' bn] существует хотя бы одна точка минимума

J (и) на [at Ь]. Поэтому намеченная выше схема поиска минимума

оправдана.

10 МИНИМИЗАЦИЯ ФУНКЦИИ ОДНОЙ ПЕРЕМЕННОЙ \Гл. J

Определение 2. Пусть J(u).^Q*[at b] и пусть вычислены

значения 1{щ) в некоторых точках {wje[a, ft], (i=l, ..., п). Ска-

жем, что тройка точек an, &n, ип, локализует точку минимума J (и)

на {а, &] по точкам {щ} (i=l9 ..., п)_у если: 1) ап, &п, ип содержат-

ся среди точек а, 6, иь ..., ип; 2) J(Un) =minJ(щ)\ 3) an<un<.bn\

__ i<t</i

4) кроме wn,'интервалу an<w<6n не принадлежит ни одна из то-

чек ии_ ип (т. е. на интервале ап<и<Ьп имеется лишь одна

точка ип, в которой вычислено значение функции).

На практике часто бывает, что мы заранее ограничены числом

точек {wi, ..., an}e[a, &], в которых можно вычислить значение

функции J (и). Такое ограничение естественно во всех тех случа-

ях, когда каждое вычисление J (и) трудоемко. Например, значения

J {и) могут определяться в результате дорогостоящего эксперимен-

та или сложных вычислений на ЭВМ. Возникает вопрос, как нуж-

но выбирать точки и\, ..., ип и как вести поиск минимума, или, ко-

роче, какой должна быть стратегия поиска минимума, чтобы по

наблюдениям значений функции в этих точках определить точку

минимума и* с наименьшей возможной погрешностью? Кроме то-

го, одна и та же стратегия поиска, примененная к различным

функциям из некоторого класса, по-видимому, будет давать раз-

личные погрешности в определении и*: для некоторых «удачных»

функций эта погрешность может оказаться равной нулю, для дру-

гих «неудачных» функций погрешность может быть значительной.

Как же выбирать стратегию поиска, чтобы она давала по возмож-

ности меньшую погрешность даже для самых «неудачных» функ-

ций из данного класса, например класса Q*[a, &]?

Оказывается, при ответе на эти вопросы следует различать за-

дачи А и Б. Поясним это на примере п=2. Пусть /(m)gQ*[0, 1],

пусть минимум J (и) на (0, 1] достигается в точке м*е[0, 1]. Возь-

мем точки их=—(1 — б), и2 =— (1+б),0<6<0, 1 и вычислим зна-

чения /(Hi), J(u2). Может оказаться, что J(u\) ^]J(u2). Тогда

ы*е[0, и2]. В задаче А в этом случае в качестве приближения к и*

естественно принять точку и*2 = их с уже вычисленным значением

J{u{) «/(и*). При этом гарантированная точность есть \и* — ы*2\ <

<—=—, поскольку в худшем случае для некоторых функций из

Q*[0, 1] может быть и*=0. В задаче Б в качестве приближения к

и* можем принять и£ = —(1 + 6) —середину отрезка [0, и2], ибо

значение J(ul) здесь нам не требуется, и получим лучшую гаран-

тированную точность \и*—и*|< —(1+6), чем в задаче А. Слу-

§ 3}

Оптимальный пассивный поиск в задачах А и Б

11

чай J{ti\)>J(ti2) рассматривается аналогично и приводит к тем

же оценкам |и* —и*| для задач А и Б. Заметим, что для зада-

1 2

чи А возможен более лучший выбор точек иг = —и иг = —,

о о

дающий гарантированную на классе Q*[0, 1] точность, равную —,

о

в то время как для задачи В такой выбор точек гарантирует по

сравнению с предыдущим меньшую точность.

Наконец, еще одна тонкость: при решении задачи А или Б,

оказывается, следует различать два принципиально различных

способа выбора точек ии ..., иП9 в которых вычисляются значения

функции: 1) все точки ии .., ип задаются заранее, до начала вы-

числений (до начала экспериментов) — это пассивный поиск;

2) эти точкет выбираются последовательно в процессе поиска с

учетом результатов предыдущих вычислений (экспериментов) —

это последовательный поиск. Об этом речь пойдет в следующих

параграфах.

Упражнения. 1. Как нужно доопределить функцию J(u) =

= Uul , , в точке и=0, чтобы 7(и)е=0[0,1]?Q[-1, 1]? Q[-l, 0]?

2. Как нужно доопределить функцию / (и) = { ' ^ \

I— и-к А, и<0\

в точке и = 0, чтобы J(u)£Q[0,1]? Q[— 1,0]? Q[—1,1]? Q[a,6]

при любых a, 6? Рассмотреть случаи А = 0; +1; — 1.

3. Доказать, что функция J (и) строго квазивыпукла на проме-

жутке £/={и: a^zu^:b} тогда и только тогда, когда J(au+

+ (1—a)v)^.max{J(u)\ J(v)} при всех w, ие£/ и всех а,0<а<1,

причем равенство может достигаться лишь при J(u)=J(v).

4. Если /i(w), /2(w)eQ[a, 6], то будут ли принадлежать Q[at b]

следующие функции: J\{u)+J2(u)t J\(u)—J2(u), J\(u)-J2(u),

/i(")//2(")?

5. Как следует выбирать две точки ии w2e[0, 1], чтобы точку

минимума J(u)^Q*[Qy 1] найти с наилучшей точностью, гарантиро-

ванной для всех функций из Q*[0, 1] в случае задач А и Б?

§ 3. ОПТИМАЛЬНЫЙ ПАССИВНЫЙ ПОИСК В ЗАДАЧАХ А И Б

Определение 1. Пусть 7(tt)EQ*[a, b]. Скажем, что на от-

резке (a, Ь] задана пассивная стратегия Рп> если: 1) на [a, Ь] за-

ранее задаются все п точек {щ} (i=l, ..., п)у Uo=a^U\<.u2<....

... <wn^«n+i=6 и вычисляются значения 1(щ) (t=l, ..., п)\

2) путем сравнения величин 1(щ) (t=l, ..., п) определяются точ-

ка uk, в которой / (uk) = min J(ut)9 и отрезок [uk-u uk+i]t содер-

жащий точку м* минимума J (и) на [a, Ь] (таким образом, точки

12 МИНИМИЗАЦИЯ ФУНКЦИИ ОДНОЙ ПЕРЕМЕННОЙ [Гл. 1

Uk-i, uk, tih+i локализуют точку минимума); 3) имеется правило, по

которому одна из точек w*6[«bb«Hi] принимается в качестве

приближенного значения для w*. Поиск минимума, осуществляе-

мый с помощью пассивной стратегии, будем называть пассивным

поиском [230].

Возьмем две пассивные стратегии Pn={ui} uPn = {ui} на

[а, Ь]. Какая из этих стратегий лучше? Как их сравнивать? При от-

вете на эти вопросы будем различать задачи А и Б.

1. Начнем с задачи А. Пусть для некоторой функции /(и)е

^Q*[a, b] с помощью пассивной стратегии Pn={u>i} (*=1, .., п)

среди точек {иг}е[а, Ь] выбрана точка uk9 J(uk) = min J(ut) и от-

i<t<fi

резок [uk-u Uk+iii содержащий точку и* минимума J (и) на [а, Ь].

В задаче А в качестве приближения к н* принимаем точку и*п = uk,

допуская при этом погрешность

\и*~ип\<тах{"Н-1 — uk> »k — ил-i}.

Очевидно любой другой выбор и* с вычисленным J(u^) для

некоторых функций из Q*[a, b] приведет к большей погрешности.

Для любой фиксированной стратегии Рп={щ} нетрудно указать

функцию /(tt)eQ*[a, 6], для которой отрезок [uh-U uk+i]> содержа-

щий точку щ*у будет совпадать с любым из наперед йзятых от-

резков [Ui-x, U{+{\ (/=1, 2, ..., п) и погрешность \и* — и*п\ будет как

угодно близкой к max{^+i—uif щ—щ-\) (например, если

Шах {щ+\—Uu Ui—Ui-i}=Ui+\—щ, то можно взять

' — и -\- ui+i—е при и^.щ+1—е,

— (ut+i— Ui-i)(u — ut+i + е) при и>и{+1—е,

где е достаточно малое положительное число). И поскольку

заранее неизвестно, какой из отрезков, [#t-i, Щ+\] содержит и*, мы

вынуждены рассчитывать на самую «неудачную» функцию J(u)^

^Q*[#, b] и в качестве гарантированной на Q*[af &] точности в оп-

ределении и* с помощью стратегии Рп должны взять максималь-

ную из возможных погрешностей;

max max {w*+i — и{> ut — щ-\} = max {wl+i — u{) = L* (Pn, b — a).

Величина L% (Pny b — a) от J(u)^Q*[ayb] не зависит и ха-

рактеризует стратегию Рп на классе функций Q*[atb].

Теперь естественно считать, что пассивная стратегия Рп луч-

ше другой пассивной стратегии Рп$ если

/*(Ря,6-а) <LUP'n,b-a).

JB(u) = \

$ 3) Оптимальный пассивный поиск в задачах А и Б 13

Обозначим

I*(b — a) = izAl£(Pn9 b-a)t

Рп

где нижняя грань берется по всем пассивным стратегиям.

Определение 2. Пассивную стратегию Рп назовем опти-

мальной для задачи А, если Ln(b — а) = Ln (Р*, 6 — а).

Теорема 1. Для задачи А при всех п^\ оптимальная пас-

сивная стратегия существует, единственна и имеет вид

Доказательство. Прежде всего, очевидно Ln(P*n> Ь — а) =

= —.Для любой другой пассивной стратегии Рп={щ) : Д==

п+ 1

i=a0^tti<w2< — <wn^«n+i==& всегда найдется отрезок [uh,

Uk+i] длины t/ft+i—uk > — ибо в противном случае сумма

п -f-1

длин всех отрезков [ui9 ui+i] (f=0, 1, ..., п) будет меньше длины

отрезка [а, Ь]. Следовательно,

Ln (Рп> Ь - а) = max {и,+1 - щ) > -^L

<Xf <п п + 1

для любой пассивной стратегии Рп, причем равенство здесь дости-

гается только при Рп = Рп. А

2. Теперь перейдем к задаче Б. Пуеп> с помощью пассивной

стратегии Pn={Ui} для некоторой функции 7(«)eQ*[a, b] найден

отрезок [Wft-i, Wfc+i], содержащий точку а* минимума J (и) на [а, 6].

В задаче Б значение J(и*) нас не интересует, поэтому в качестве

приближения к w* можем взять и*=—(tfe-i + и*н)» допуская

при этом погрешность |н* — ы*|<— (wa+i—w^-i) (любой другой

выбор и*п может привести к увеличению погрешности при соот-

ветствующем выборе 7(«)sQ*[a, &]). Эта погрешность зависит от

выбора стратегии Рп и функции /(w)eQ*[a, 6]/Для любой фик-

сированной пассивной стратегии Рп={и{} нетрудно указать функ-

цию /(w)eQ*[a, &], для которой отрезок [uh-\rU>h+\\ содержащий

точку и*, будет совпадать с любым из наперед взятых отрезков

[Ui-u "я-i] (*=1, ..., п), и погрешностьIи* — и*п\ будет как угодно

близкой к —(щ+х —a*_i) (см., например, функцию Je(u) из п. 1).

И поскольку заранее неизвестно, какой из отрезков [ai-ь #г-м] со-

держит и*, мы вынуждены рассчитывать на самую «неудачную»

14 МИНИМИЗАЦИЯ ФУНКЦИЯ ОДНОЙ ПЕРЕМЕННОЙ* [Гл. 1

функцию J (и) из Q*[a> b] и в качестве гарантированной на Q*[a>b]

точности в определении w* с помощью стратегии Рп взять макси-

мальную из возможных погрешностей:

max — (щ+х — щ-\) = Ln (Ря, Ь —а).

1<;<п 2.

Величина Ln(Pn, Ь — а) от /(w)eQ*[a, b] не зависит и характери-

зует стратегию Рп на классе функции Q*[at b].

Определение 3. Пассивную стратегию Р*п назовем оптималь-

ной для задачи Б, если L* (Рп, 6 — а) = L* (& — а) = inf L* (Ря, b—'a)*

где „вжняя граАь бередя „о всем пассивным срат^м. upa«,™

Р*п назовем е-6птимальной, если Z,J?(Р®, Ь—а)<L*[Ь — а) + е, е>0.

Теорема 2. Для задачи Б при всех нечетных n=2m+l

(m^O) существует бесконечно много оптимальных пассивных стра-

тегий, причем La (Ь — а) = """а

2 (т +1)

Доказательство. Возьмем пассивную стратегию Рд = {^} из

точек v2i = о-+1—=^- (i =1,2 m), а точки t^+i (г ±= 0, 1, ...

т+ 1

..., т) расположим на отрезке [а, 6] как угодно, лишь бы

l>2f-l < 02* <ЧМ+1» Чм+1 ?2*-1 < 7^ •

/71+ I

Очевидно, Ln (Рп, Ь — а) = ~~а , С другой стороны, /для любой

2 (т +1)

пассивной стратегии Ря = {щ} Имеем

£* (Л*> Ь— а) = — max (а^ — и<_0 >

2 i<f<»

> —max {6 — u2mt и2т — ^2m-2, • • • > и4—и2> '#2 — а} >

Ь — а

2(/п+1)

-1|?(Р;,6-а).

Следовательно, стратегии Ря оптимальны и Ln(b—a) =

> — а

2(«+1)

Теорема 3. Для задачи Б при всех четных л = 2/тг(т>1)

оптимальной пассивной стратегии не существует;

' 2 (« + !)'

§ 3] Оптимальный пассивный поиск в задачах А и Б 15

В качестве е-оптимальной стратегии можно взять

m-J- 1 m-f- 1

где 0<8<;

t = l,2, ... ,m,

b—a

*2(m+l)

Доказательство. Прежде, всего

ИЛ Ь-а) = i™ fa+, -■>,-,) = i-fc-a) = j^ + f.

Покажем, что Ln(Pn> b — a)>—""~a для любой пассивной страте-

гу +1)

гии Рп = {wj, a0 = а < йх <w2< ... <ип < Ь = wn+i. Имеются две

возможности: либо и2 ]> и = аН—^^Ц либо и2 < и. Если и2 > а, то

пг-\-1 ♦

£* (Л,, 6 — а) = 4" max (и<+1 — w£_i) >-^-(иг — а)>

2 1<*<п 2

. 1 /— ч Ъ — а

> — (и — а) =

2 v 2(m+l) "

Если же w2<w, то max (w^-i—Wi_i)>H2— а. В самом деле,

1<£<п

если бы max (tii+i— w*-i) <и2— а, то u2i+\—W2*-i < u2 — a, t =

1<е<л

= 1,2, ...,m, и, кроме того, wx— a<w2— a. Сложив последние

неравенства, будем иметь6 — a<(m + 1) (w2 — a)<(/n+ l)(w —a) =

= 6 — a; получили противоречие/ Таким образом,

L%(Pn,b— a) = 4- max (ин-i —^-i) = l5-i(Pi-b 6—«i).

2 2<f<ft

где P„_i—пассивная стратегия на [и1У 6], составленная из точек

и2> #з> • • • >ип стратегии Рп. Но п— 1 = 2/я— 1 —нечетное число, и

в силу теоремы 2 L%-\{P'n-u b — Uj) > ~~% - Следовательно,

2/п

Ц(Рп.Ь-а)>-—>

2пг 2пг 2 (т +1)

Таким образом. 1« (Р„, Ь — а)>—"~"fl> для любой пассивной стра-

r f v п 2(m + i)

тегии Рл, причем Ll(Pi b — а)< 2^{) +е Для любого б, 0<

< е < 77-^7- Следовательно, L% (Ь - а) = .*~g А

2 (т + 1) 2 (т + 1)

16 МИНИМИЗАЦИЯ ФУНКЦИЙ ОДНОЙ ПЕРЕМЕННОЙ [Гл. t

Из теорем 2—3 непосредственно вытекает

Следствие 1. Для любой пассивной стратегии Рп={ш} на

отрезке [а, Ь] существует функция 7(w)eQ*[a, b\ такая, что для

тройки точек аПу bnt ип> локализующей точку минимума J (и) на

[a, Ь] по точкам и\9 ..., ип, справедливо неравенство

bn-an>-^- = 2L*(b-a),

т-\-1

где т = — для четных п, т= п~~ для нечетных я(п > 1),

2 * 2

Как видим, при решении задачи Б с помощью пассивных стра-

тегий предпочтительнее брать четное число п=2т, поскольку

^2m+i (b — a) = Lom (b — a) =

и увеличение числа точек на единицу существенно не улучшает

точность.

§ 4. ПОСЛЕДОВАТЕЛЬНЫЙ ПОИСК

Пассивный поиск -используется, как правило; лишь в тех слу-

чаях, когда можно одновременно провести п независилСых экспери-

ментов, но нет возможностей (например, не хватает времени), для

того, чтобы ставить эти эксперименты последовательно, друг за

другом; с учетом результатов предыдущих экспериментов. Между

тем интуитивно ясно, что при выборе наилучших действий следует

использовать информацию о результатах действий, которые мы

уже произвели, и во всех тех случаях, когда это возможно, гораз-

до эффективнее использовать последовательный поиск [230].

Определение 1. Пусть 7(a)eQ*[a, b]. Скажем, что на от-

резке [а, Ь] задана последовательная стратегия Рп, если: 1) задано-

правило выбора первых нескольких точек иь и^у ..., и8^[а, Ь\.

(l^s^n), из которых определяются три точки а8, bs, ^локали-

зующие точку минимума J (и) на [а, Ь] (см. определение 2.2);.

2) если l^s<fi, то по известному правилу на отрезке [as, bs] вы-

бирается несколько точек и8+ь •••> «л (\^s<.k^.n) и среди точек

us, us+u ..., Uk определяется тройка а&, Ь&, й&, локализующая точку

минимума; если &<п, то на [а&, fc/J по некоторому правилу выби-

раются последующие несколько точек Ид+ь—»Um (l^s<.k<.m^.n)

и среди йь, Ufc+i, ...С Um определяется Очередная локализующая

тройка От* Ьт, йт и т. д. Этот процесс продолжается до тех пор„

пока не будет выбрана последняя м-я точка и определена соответ-

ствующая тройка an, bn, йп, локализующая точку и* минимума

J (и) на [a, Ь]\ 3) имеется правило, по которому одна из точек

и*п 6 [ап, Ьп] принимается в качестве приближения для и*.

§4]

Последовательный поиск

17

Очевидно: [a, b] => [aS9 bs] => [ak, bk] =э ... => [ал, 6Л], J(un) =

= min /(и,) an<Cun<bn9 ал<и*<&„ и на интервале ал<и<6/1Г.

кроме йп> нет точек с вычисленным значением функции. Отсюда

ясно, что*можно ограничиться рассмотрением только таких после-

довательных стратегий Рп, согласно которым в задаче А прини-

мается Un = ип, а в задаче Б — и\ = — [ап + 6л], ибо любой:

другой выбор приближения и*п для и* из (ап, 6П] может привести

для некоторых функций 7(«)GQ*[a, 6] к увеличению погрешности

Поиск минимума, осуществляемый с помощью последователь*

ной стратегии, будем называть последовательным поиском.

Указанный выше, способ выбора и* в задаче А приводит к

погрешности \ип — и*\ < max {Ьп — и*п, ип — ап}, причем для любой

фиксированной последовательной стратегии Рп нетрудно указать

функцию 7(w)sQ*[a, 6], для которой эта погрешность будет как

угодно близкой к тах{&д — и*п> ип — ап}. Для выбранной страте-

гии Рп в качестве точности, гарантированной на классе Q*[a, b]„

естественно теперь взять число

&% (Рп>Ь—а)= sup max {bn — иЛ> < — ап).

J€Q4aM

Определение 2. Последовательную стратегию Рп назовем

оптимальной для задачи А, если

ti(Plb — a) = inltflPn9b — a) = ti(b-a),

где нижняя грань берется по всем последовательным стратегиям.

Стратегию Р\ назовем е-оптимальной, если б£(Рл, b—a)<i

<fi» (b — я)+е, e>0. Для задачи Б аналогично определяются

погрешности

\»m-»n\<-lr(bn-an), ЬБп(РП9Ь-а) =

= sup -±-{Ья-ая)9 &пъ(Ь-а) = т\Ьпъ{Рп9Ь-а)9

JeQ'la.b] 2 Рп

понятия оптимальной и е-оптимальной стратегий.

Допустим, что мы построила какую-либо последовательную»

оптимальную (или е-оптимальную) стратегию гп для минимиза-

ции функций из класса Q*[a, b]. Пусть теперь на каком-то другом

отрезке [с9 d] нам нужно минимизировать функцию из Q*[c, d\.

Возникает вопрос: нельзя ли стратегию Рп.Для отрезка {а, Ь] ис-

18 МИНИМИЗАЦИЯ ФУНКЦИЙ ОДНОЙ ПЕРЕМЕННОЙ [Гл. 1

пользовать для построения оптимальной (или е-оптимальной) стра-

тегий поиска минимума на отрезке [с, dp Для ответа на этот воп-

рос возьмем линейное преобразование v = —^- (и — а) + с, пере-

b — а

водящее отрезок [а, Ь] в [с, d]9 и каждой функции G(ti)eQ*[c,d]

поставим в соответствие функцию

J(u)^G{±^(u-a) + c^eQ*[a,b].

Очевидно, 'при этом между классами функций Q*[a, b] и Q*[c, d]

будет установлено взаимно-однозначное соответствие. Теперь ес-

тественно принять следующее

Определение 3. Применением стратегии Рп к отрезку [с, d]

для минимизации функции G(u)eQ*[c, d] будем называть после-

довательный выбор точек

Vt = 4—- (^ —а) +^€ [^э d], (i = 1, 2,... ,п)

о — а

по тем же правилам и в той же последовательности, по которым

выбираются точки щ^[а, b] (t=l, 2, ..., п) с соответствующими

номерами при применении стратегии Рп для минимизации функ-

ции J(u)==G (——^- (и — а) + с j на отрезке [а, 6].

После принятия такого определения имеет смысл говорить о

стратегиях Рп безотносительно к отрезку,- на котором ищется ми-

нимум строго квазивыпуклой функции. Нетрудно видеть, что для

любой стратегии Рп и любого числа а>0 имеют место равенства

б£(Рл,а(Ь-а)) = аб£(Рл, 6-а), б£(а(6-а)) =аб£(6-а).

Аналогичным свойством однородности по переменной b—а обла-

дают также величины Ъп(Рп>Ь — а)% &п(Ь — а) для задачи Б: чем

меньше длина отрезка, тем лучше гарантированная точность в оп-

ределении точки минимума с помощью одной и той же страте-

гии Рп.

Естественно распространить определение 3 и на пассивные

стратегии. Тогда величины

Lt(Pn> b-a)t L%(b-a), Lbn(Pn, b-a), L*(b-a)

будут обладать упомянутым выше свойством однородности по

переменной Ъ—а.

§ 5. МЕТОД ДЕЛЕНИЯ ОТРЕЗКА ПОПОЛАМ

Простейшим примером последовательной стратегии является

метод деления отрезка пополам [230]. Суть этого метода проста.

§5]

Метод деления отрезка пополам

\9

Пусть 7(t/)eQ*(a, b], а и* — точка минимума J (и) на [a, Ь]. Возь-

мем точки

Ч = -J (а + Ь — б), и 2 = JL (а + 6 + б) = а + Ь ■ — ulf

где 6=const, 0<б<6—а. Величина б может характеризовать по-

грешность измерений величины и и ограничена снизу возможно-

стями измерительного прибора. Точки ti\9 и% расположены симмет-

рично на отрезке [a, Ь]9 при ма-

лых б делят [a, Ь] почти попо-

лам — отсюда название метода.

Далее, вычисляем и сравниваем

значения /(wi), J{u2). Если

J(ui)^Hu2)> т0 полагаем

а\=а, b\ = ii2\ если же J(u{)>

>/(«2)>то a\=uub\ = b (рис.1).

В результате получим отрезок

[du Ь{\> содержащий точку а*

минимума функции J (и) на U,

причем

, Ь~а+Ь

Рис. 1

Если отрезок [яа-j, bk-i], содержащий точку и*, уже изве-

стен и

то дальше на этом отрезке поступаем аналогичным образом. А имен-

но, берем точки

— flft-i + bk~i — б __ gj?.i + bk-\ + б .

И2*-1 = 2 * 2Л 2—'— —

расположенные симметрично на отрезке [ak-u 6fe-i]> и вычислим зна-

чения J(ii2k-\)> «Г (****)• Если J(u2k-\)KJ(u2k)y то полагаем afe = afe-u

&* = "2*> если У (tf2*-i) > / (u2k), то- аЛ = н2*-ь h = fr*_i. Отрезок

\ak> h] содержит точку и* минимума; его длина

Ьь — ak =

Ь — а

=^+(l__L)e>e.

Допустим, что требуемое число вычислений n=2k значений

функций мы провели и остановились на отрезке [ан, Ьъ\. Тогда в

20 МИНИМИЗАЦИЯ ФУНКЦИИ ОДНОЙ ПЕРЕМЕННОЙ [Гл. t

качестве приближения для точки минимума а* в задаче Б примем

ип = — (ak + bk), допустив при этом погрешность

В задаче А примем

Un=U2k-l При J(U2k-\)<J(u2k)t Un = U2k ПрИ J (U2k-\)> J (u2k)

с уже известным значением J(un); допускаемая при этом погреш-

ность

\u*-tin\<bk-ak < JjZ£- + 6.

Зная величину погрешности в определении и* при Л-кратном де-

лении отрезка пополам, легко подсчитать число n=2k вычислений

значений функции для получения и* с нужной точностью е,

е>6>0.

Заметим, если для функции J(u)^Q[ayb] нижняя грань J (и)

на U не достигается, то при 6^-0, £->оо описанный метод позволя-

ет строить минимизирующую последовательность — для этого до-

статочно, например, взять упомянутые выше величины #Л, л =

=2£(£=1,2, ...)♦ Метод деления отрезка пополам может быть ис-

пользован для поиска минимума произвольной непрерывной функ-

ции на отрезке [а, Ь], однако в результате придем, вообще говоря,

к точке локального минимума.

Сравнивая полученные выше оценки погрешности \и*— ип\

для функций из класса Q*[a, b] с оценками из теорем 3.1 и 3.3, не-

трудно убедиться в преимуществе метода деления отрезка пополам

по сравнению с пассивным поиском уже при небольших n=2k.

Однако существуют последовательные стратегии, которые лучше

метода деления отрезка пополам.

§ 6. ОПТИМАЛЬНЫЙ ПОСЛЕДОВАТЕЛЬНЫЙ ПОИСК

ДЛЯ ЗАДАЧЛ А

Оказывается, оптимальная последовательная стратегия для за-

дачи А связана со знаменитыми числами Фибоначчи, и поэтому

эту стратегию будем называть стратегией, или планом, Фибо-

наччи.

§6]

Оптимальный последовательный поиск для задачи А

21

Как известно [56], числа Фибоначчи определяются так: /7п+2=

=Fn+\+Fn, (-я=1, 2, ...); Fi=F2=l. Нетрудно показать, что

Перейдем к описанию* плана Фибоначчи Фп (п^1). Пусть

J(M)eQ*[a, b]. При /1=1 план Ф\ прост: берем ux = —^— и вы.

числяем значение J(u\). Полагая U\ = uv определим точку мини-

мума н* с погрешностью

|л* *i ^ Ь — а Ь — а

\u-m\K-j- —.

Пусть теперь я>2. Тогда план Фп начинается с выбора двух

точек

ux = a + ~i-ib-a)9 aa = a + -|5±L-(6-a) = a + 6—иъ

расположенных на отрезке [а, Ь] симметрично, и вычисления значе-

ний J(ux)f J(u2). Если y(ttx)</(a2), то полагаем а2 = а, Ь2 = и29

Щ = ui> если же ' (ui) > J (и%)> то a2 = Щ.% Ь% = 6, и2 = и2, В резуль-

тате получаем отрезок [а2, Ь2] длины

_ Ь2 — а2 = Ь — их = и2~а= *+|. (6 —а)>

содержащий точку и* и точку и2, а2<и2<62, в которой

/ (и2) = min {J (и±), J (uj).

Заметим, что точка и2 совпадает с одной из точек

^ = я2 + -^—(Ь2-а2) = а2 + -р^-(Ъ-а) (при J(ud<J(ujy

ИЛИ

= а2 + Ь2— и2 (при J (их) >/ (и2))ч

Далее на отрезке [а2, Ь2] выбираем следующую точку и3~а2 + Ь2 —

— и2, вычисляем J(u9) и сравнением величин J(u2)9 J (и9) находим

ловый отрезок [а8, Ьв] и т. д. (рис. 2). В общем случае, пусть точ-

22 МИНИМИЗАЦИЯ ФУНКЦИЙ ОДНОЙ ПЕРЕМЕННОЙ [Гл. /

^ЛЧ^Ч6

(п-4,ига*$(6 а), иу-а. 1(6-а))

Р и с._2

ки и1э ... , wft(2<£<tt) уже выбраны, пусть найден отрезок

[<*k> h] длины #

содержащий тощсу и* и точку uk, ak<uk<C.bk> с вычисленным зна-

чением J(uk) = min J(ui)f причем точка uk совпадает с одной из

KKk

точек

а;-аЛ + ^ьЛ^(ЬА—aft) = aA + -%=&^(ft —а)

ИЛИ

^ = ^ + 4*^ <**-**) = **+^^

^n-Л+з **я+а

Если &<>, то на отрезке [ak, bk] выбираем следующую точку:

Uk+\ = ak+ bk—ukt симметричную с uk на этом отрезке и совпада-

ющую с одной из точек u'k, ukt отличной от ик. Вычислим значение

J(Wfe_j-i) и сравним с J{uk). Пусть для определенности ^ = ^<w^=

= Uk+i (случай uk+\ = «л < uk = и* рассматривается аналогично). Тог-

да при J(uk)<J {Uk+\) полагаем о*+1 = akf bk+l == Mfe+b tfft+i = ал.

Если же J(uk) > У (iik+\), то a*+1 = ил, bk+\ = &*, tfft+i = uk+i- в Ре-

зультате получаем отрезок [ak+u &ft+i] длины

содержащий точки и* и uk+u ak+\ < Wfe+i < *Н-ь с известным значе-

нием J(afe+i)= min J(a£), причем точка Мн-i совпадает с одной из

точек

# 6] Оптимальный последовательный поиск для задачи А 23

иш = ak+l + "-" {bk+l - аш) = аш + n~k (b — a)

ИЛИ

uk+l = ak+x + Fn~k+1 {bk+x — ak+1) =

fn-k+2

= ац-i + f*"*+1 Ф — a) = аж + 6fc+i — u'k+x,

и Т. Д.

Если & = я, то процесс заканчиваем и полагаем ип= ип с вы-

численным значением J(u)=s min/(W;). Заметим, что при k = n

г ^ т *****

длина отрезка [ап, Ьп\ равна

ьп—ап= ' (Ь — а) = ——'-,

И ТОЧКИ

u'n = an+ Fl ф—а) =ап

^Я+2 ^Я+2

F2 /t _ч _ , 6 —a

(6 — д) = ал +

гЛ+2 *П+2

совйадают_и делят отрезок [ад, Ьп] пополам. Таким образом, прини-

мая ип = ип = ия = иЛ> мы допускаем погрешность

независимо от выбора функции J (u)£Q*[af Ь]. Нетрудно видеть, что

для функции / (и) = и 6 Q* [а, 6] план Ф„ дает погрешность в опре-

делении и* = а, в точности равную —=^-. Следовательно,

6*(ФД, 6-а) = -^Ц/г>1).

План Фибоначчи Фп полностью описан [56], [230].

Отметим одно замечательное свойство плана Фп: применение

плана Ф«— k+i к отрезку [а&, &ь], полученному в результате пер-

вых k шагов плана Фибоначчи ФЛ, равносильно дальнейшему про-

должению плана Фп на этом отрезке [а&, bu], (l^k^Zn). Этот факт

вытекает из того, что первые две точки плана Фп*-к±\ совпадают

с точками u'k, Uk, или, что то же самое, с точками uk, Uk+\ пла-

на Фп.

План Фибоначчи Фп прост и удобен для использования на

ЭВМ.

24 МИНИМИЗАЦИЯ ФУНКЦИИ ОДНОЙ ПЕРЕМЕННОЙ [Гл. /

Теорема 1. Для задачи А план Фп является оптимальным;

6*(ФД, 6-a) = inf6£(P„, b-a) = tf(b-a)=-^-.

Других оптимальных последовательных стратегий нет.

Доказательство будем проводить индукцией по п. При п=1у

очевидно, все утверждения теоремы верны. Пусть оптимальность

плана Ф* и единственность оптимальной последовательной страте-

гии доказаны при всех k=l9 2, ..., п—11 (л^2). Покажем, что тог-

да план Фп оптимален и других оптимальных стратегий нет. Возь-

мем произвольную последовательную стратегию Рп (п^2). Со-

гласно определению 4.1 стратегии Рп вначале выбираются точки

ии ..., u8^[at b] (I^s^m), и сравнением величин J(u\)y ..., J(us)

находится отрезок [as, b8], содержащий точку минимума и* и точку

й8 с вычисленным значением / (us) = min J{ut). Не умаляя общ-

l<i<s

яости, можем считать, что 2^5^п. В самом деле, задание одной

точки щ (5=1) ничего не добавляет к известной информации о

том, что а^.и*^:Ь, и поэтому остается переходить сразу ко второ-

му шагу стратегии Рп, заключающемуся в задании следующих не-

скольких точек и2, .., us (5^2), что, конечно, равносильно заданию

точек щ9 иг, ..., и3 (s^2) с самого начала, на первом же шаге

стратегии Рп. Итак, 2^5^л. ~

Отдельно рассмотрим случай s=2^n, когда стратегия Рп на-

чинается с выбора двух точек щ, и^ a^tti<CM2^6. Начальные

точки плана Фп обозначим через

и\ = а + -^— (Ь — a), u2=a + J^-(b — ay.

Fn+2 Fn+ъ

Начнем со случая иг<^и\. Если /(«i)>/(«2), то точка а* мини-

мума будет находиться на отрезке [щ9 Ь] длины Ъ — иг>Ь — и\у

причем для поиска и* на этом отрезке мы можем вычислить зна-

чение функции J (и) еще в п—1 точках, включая точку гё2=и2.

Если даже точка й2 на отрезке {ци Ь] расположена так удачно а

допускает применения оптимального (в силу индукции) плана Фп-\

на [u\9 b] с участием точки м2, то и в этом случае/гарантированная

погрешность в определении и* будет больше, чем при применении

плана Фп на [a, Ь]:

б* {Ра,Ь-а)> Ы.1 (Ф-ь Ь - и,) = ±=2±- > -р- =

= ±^- = ЬА(Фп,Ь-а).

§ 6] Оптимальный последовательный поиск для задачи А 25

Таким образом, стратегии Рп, начинающиеся с выбора двух

точек ии и2у a^U\<.U2^bt где «i<Wi, заведомо неоптимальны.

Аналогичные рассуждения показывают, что стратегии Рп с выбо-

ром точки u2>U2 также не могут быть оптимальными.

Пусть теперь и{^>и\. В худшем случае точка и* может на-

ходиться на отрезке [а, и\] длиной

* F

ux — a^>ui—а = —-—(Ь — а),

Fn+2

и на поиск и* на этом отрезке в нашем распоряжении остается

еще п—2 вычисления значений функции. Но если даже стратегия

Рп такова, что дальнейший поиск и* на [а, щ] совпадает с опти-

мальным планом Фп-2, то и в этом случае гарантированная по-

грешность в определении и* будет больше, чем при применении

плана Фп на [а, Ь\.

ti(Pn. Ь-а)>Ь*-2(Фп-2, u1.-a)=^^>^ff- =

= Л=Л- = Ь£(Фп,Ь-а).

ГП+2

Таким образом, стратегии РП9 начинающиеся с двух точек

ни u2t a^Ui<.U2^b> где ^.>«*, заведомо неоптимальны. Ана-

логично доказывается неоптимальность стратегии Рп вг случае

и2<и2.

Остается рассмотреть случай и± = и\> и2 = и2, когда первые две

точки стратегии Рп и плана Фп совпадают, и сравнение величин

J_(u\)} JJ112) приведет к отрезку [a2i bl], содержащему точки и* и

и2 с J (и2) = min {J (и*), Jiul)}. На поиск и* на этом отрезке в на-

шем распоряжении остается вычисление значений функции еще в

п — 1 (п > 2) точках, включая точку и2. Продолжением плана Фп на

отрезке [а2, 6J является план Фп-\ на этом отрезке, являющийся

единственной оптимальной последовательной стратегией по предполо-

жению индукции. Поэтому любое отклонение стратегии Рп на \а2,

Ь2] от Фп приведет лишь к увеличению гарантированной погрешно-

сти:

б^(Ря,6-а)>б^1(Фя«ь bl-al) =Ь${Фп,Ь-а)

при РпфФп. Таким образом, среди стратегий РЛ, начинающихся с

выбора двух точек их, и2 6 [а, Ь] (5=2), наилучшей является план

Фибоначчи Фп. В частности, при п = 2 наилучшим будет план Ф2.

26 МИНИМИЗАЦИЯ ФУНКЦИЙ ОДНОЙ ПЕРЕМЕННОЙ [Гл. t

Наконец, перейдем к рассмотрению пбследовательных стратегий

Рп% начинающихся с выбора s точек и19 и2, ... , ws6 [a, 6J, 2<s <

</г. В этом случае, сравнивая значения J(«i), ... , J{us), мы най-

дем отрезок [aSi 6S], содержащий точки и* и us, as<us<bs с вы-

численным значением J(a^) = min J(u{). Согласно следствию 3.1 при

любых, даже самых наилучших действиях на классе Q* [а, Ь] будем

иметь bs — as > —=^-, где т = -^- при четном st т = ——— при

нечетном s(m> 1). В то же самое время, оказывается, первые s ша-

гов плана Фп приводят к отрезку [al, b*s] меньшей длины

Ь\ - as = -Z^±± (b-a) <±^<bs-as.

Fn+2 m + 1

Это вытекает из следующих неравенств:

2Fn+2>(s+l)/wH* при s=2m+l, 3<s<n, (1)

2Fn+2>(s + 2)F/I_s+3 при s=2m, 4<s<n. (2)

Справедливость неравенства (1^ при s=3 и (2) при s=4 легко

установить с помощью индукции по п. При всех 5^4, оказывает-

ся, верно более сильное неравенство (2), вытекающее из монотон-

ного убывания (5+2) Fn_s+3 при возрастании 5 от 5=4 до s=n:

(s + 2) Frt_s+3 = (s + 2) Fn-s+2 +(s + 2) Fn-s+l >

>(s + 2)Fn-$+2 + F„_s+2 = (s + 3) Fn-s +2.

При поиске точки и* на отрезке [а$, bs] можно вычислить зна-

чения функции еще в п—s+1 точках этого отрезка, включая точку

ws. Если даже точка us Ha[as, bs] расположена очень удачно и до-

пускает применение оптимального (в силу индукции) плана Фп-s+i

на отрезке [aSi bs] с участием точки uSi мы сможем получить лишь

б£(/>„,&-а) >б£_5+1(Ф„_Ж( bs-as)= -^£->-^fi_ =

= _Ёр£_ = б*(Ф„, 6-а).

^Л+2

Таким образом, случай 2<s</2 также рассмотрен. ^

Теперь нетрудно ответить на следующий практически важйый

вопрос: сколько следует произвести наблюдений значений J (и),

чтобы с заданной точностью е>0 определить точку w* минимума

7(tt)eQ*[a, &]? Количество необходимых для этого наблюдений

§ 7] Оптимальный последовательный поиск для задачи Б 27

в задаче А равно наименьшему из чисел п, удовлетворяющих не-

равенствам

<е<— или Fn+\< <^Л+2.

Fn+2 гП+1

Очевидно также, длина отрезка [а, &], на котором можно найти

точку и* минимума функции /(w)eQ*[a, b] с заданной точностью

е>0, произведя п наблюдений значений J {и), не превышает

fFn+2-

§ 7. ОПТИМАЛЬНЫЙ ПОСЛЕДОВАТЕЛЬНЫЙ ПОИСК

ДЛЯ ЗАДАЧИ Б

Теорема 1. Для задачи Б наименьшая возможная гаранта-,

рованная на классе Q*[a, b] погрешность равна 6„ (Ь— а) = ——^-,

однако оптимальной последовательной стратегии Рп при п>\ не

существует.

Доказательство. Прим=1 независимо от выбора точки

#i £ [я> Ь] (и даже не вычисляя значения J (иг)) можем положить

* а 4-b i * * i ^ Ь—а Ь — а ^

щ = —-— с погрешностью \и —и\ | < = . Очевидно,

2 2 2/*2

любой другой выбор и* может привести лишь к большей погреш-

ности. Теперь покажем, что для любого е, 0 <е<—^-, и лю-

бого я> 1 можно построить последовательный план Ф„, для кото-

рого

- „_ <Ььп(Фьп,Ь-а)<-^- + г.

План Ф„ будем строить следующим образом. На отрезке [а, Ь\ сна-

чала реализуем описанный при решении задачи А фибоначчиев план

Фя-1= ф£_1 и получим отрезок [ап_ь Ьп-\\ длины

Оп-\ —ап-\ = ,

содержащий точку минимума и* и точку

с вычисленным значением

/ (йд_,) = min / (w,) (п > 2, а2 = а, 6Х = Ь)

28 МИНИМИЗАЦИЯ ФУНКЦИИ ОДНОЙ ПЕРЕМЕННОЙ. [Гл. Т

После этого положим ип = ип-\ + е, вычислим значение J (ип) и оп«

ределим "точку ип следующим образом:

ип =

— (ац-i + ип)9 если J (ип^) < /(ип)9

-i- (art-i + б/i-i), если J(un-i)>J(un).

Принимая (/я в качестве приближения для и*, допустим погрешность

*г—м

"ад " '

Я+1

Таким образом, план Ф„, гарантирующий погрешность, как угодно

близкую к

6 —А

2Fn+1

, построен при всех п >2 (рис. 3).

"А "*

(n*4,uf* а+$ (6а), и2* а > $ (6-а))

Рн с. 3

Далее докажем, что

8* (6 — а) = inf 6* (Ря, 6 —а) = J^£L при всех п = 1, 2,

а также убедимся в том, что &п(Р„, * — а)>~^ для любой пос-

ледовательной стратегии Рп при всех" п > 2. Как было показано

выше, при я= 1 имеем 6? (6 — а) = ■ *""*■. При л = 2, очевидно,

Ai 2

ДБ/о t ч^ & —а ^ — fl

ЫР>, *-«)>—7-=—57"

для любой стратегии Р2. С другой стороны, для "любого е>0 мож-

но указать стратегию Фз, для которой

§ 7] Оптимальный последовательный поиск для задачи Б 29

Следовательно,

bB2(b-a)=inib*2(P2tb-a) = ,

причем нижняя грань здесь не достигается. Сделаем индуктивное

предположение: пусть

для любой последовательной стратегии Pk при всех & = 2, 3, .•..

п — 1, (п > 3), и докажем, что тогда

bUb-a)=J^-<bBn(Pnt Ь-а)

для всех последовательных стратегий Рп.

Возьмем произвольную последовательную стратегию Рп

(я^З). Согласно определению 4.1 стратегии Рп вначале выбира-

ются точки in, и2, ..., wse[a, 6], (I^s^az). Как и в задаче А, не

умаляя общности, можем считать, что 2^'s^n (см. доказатель-

ство теоремы €. 1).

Сначала рассмотрим случай s = 2 < л, когда стратегия Рл начи-

нается с выбора двух точек а^их<и2КЬ. Начальные точки пла^

на ф£-1 на [a, Ь] обозначим через

*Wi Fn+i

Возможно u% < w* или uL > иь Пусть сначала иг < и1. Тогда в худ-

шем случае u*£[uit b], причем для поиска и* на [и19 Ь] можно»

вычислить значение функции еще в п — 1 точках этого отрезка,,

включая тбчку Ъ2 с известным значением J (и2). В [силу предполо-

жения индукции при любом выборе точек и3, , йп и любом рас-

положении точки и2 на [uv b] точку и* можно получить с гаранти-

рованной погрешностью, большей

Следовательно,

Ь—их ^ Ъ — их _ ь — а

2Fn * 2Fn "" 2Fn+1

Ь*п(РП9Ь-а)>.Ь-а

2F>

n+i

Для любых стратегий Рм начинающихся с выбора двух точек и1г

иг> a<£/1<w2<*, где иг<ии Аналогичные рассуждения показы-

вают, что для стратегий Рп с выбором точки и2 >u2(s = 2) также

30 МИНИМИЗАЦИЯ ФУНКЦИИ ОДНОЙ ПЕРЕМЕННОЙ [Гл. 1

ЬБп(Рп>Ь-а)>Ь а

2Fn+1

Пусть теперь и^и]. В'худшем случае точка и* может на-

ходиться на отрезке [а, и\] длиной

и1^-а>щ—а = п~х (Ь — а),

Fn+i

и для установления этого обстоятельства мы должны сделать по

крайней мере три вычисления значений функции, причем хотя бы

одно из них во внутренней точке отрезка [а, и{\. Следовательно, для

поиска и* на [а, и{\ в своем распоряжении мы имеем самое боль-

шее п—2 вычисления значений функции на этом отрезке. Однако

по предположению индукции

сБ / ч Hi— а ^ их—а Ь — а

6/i-2(Wi —а) = —h >"

2F/I-1 %Fn-i 2F/1+1

так что

ЬБп(Рп, Ь — а) > Ь~а и при %>м1.

Аналогично доказывается это неравенство для случая u2<Cul. Та-

ким образом, для всех стратегий Рп% начинающихся с выбора двух

точек и19 щ 6 [a, b] (s = 2), имеем

ЬБп(Рп> Ь-а)>-±р-(п>3).

Перейдем к рассмотрению последовательных стратегий Рп, начи-

нающихся с выбора s точек и19 и2У , us 6 [a9b]9 2<s<n. В этом

случае, сравнивая значения /(их),_... , J(us), найдем отрезок [as, bs],

содержащий точки и* и uS9 as<.us<dbs) с вычисленным значением

J(us)= min J{ut)4 Согласно следствию 3,1 при любых даже самых

наилучших действиях на классе Q*[at b] будем иметь

6>^ Ь — CL S ^ Л

s — as> —--, гдет=—>2

т + \ 2

при четном .5, т = > 1 при нечетном 5 > 3.

Далее нам понадобятся неравенства:

2Fn+i>(s + 1) Fn-s+2 при всех s = 2т + 1, 3 <5<п

и

2Fn+\>(s + 2)Fn-S +2 при всех s = 2/п, 4<s<п, (1)

§ 7] Оптимальный последовательный поиск для задачи Б 31

справедливость которых при s < п — 1 вытекает из неравенств

(6.1—2), а при s = n (1) просто доказать с помощью индукции

по п.

Если в стратегии Рп оказалось s = п, то

ПУ п% ' ^ 2(m+l) 2F„+1

в силу следствия 3.1 и неравенств (1) при s — n. Поэтому пусть

3<s<n—1. Однако в этом случае первые s шагов плана Фп-\

приводят к отрезку [aSt bl] меньшей длины:

&;-*; = -^_(fr_a)<-^-<6s-aS(

^Л+1 « + 1

что вытекает из неравенств (1). Дли получения отрезка [as, bs] нам

понадобилось s значений функции, поэтому для поиска и* на [aS9 bs]

мы имеем в распоряжении _еще п — s + 1 значение функции на этом

отрезке, включая точку us с известным J(us). Однако по предпо-

ложению индукции

6rt_s+1 (6 — а) =

поэтому

6ьп(Рп,Ь-а)> °°-а° >

^S As

2Frt-s+2

bs — fls ^_a

Таким образом, доказано, что бд(РЛ, 6 — a)>—~^- для любой

2Fn+i

последовательной стратегии P„(ai>2), и, кроме того, для любого е,

0<б<—=—, существует стратегия Ф„, для которой

2^Л+1

Следовательно,

Ьвп(Ь-а)= inffi£(P„, &-с)= Ь~а

Заметим, что величина s на практике не может быть сколь

угодно малой в силу ограниченных возможностей измерительных

приборов, ЭВМ и т. п. Пусть е>0 — тот наименьший сдвиг между

числами, который можно измерить, и пусть 0<е<-гтР—• Учи-

тывая конечность числа е, вместо описанного выше плана Фъп

можно использовать следующий более точный и полностью сим-

32 МИНИМИЗАЦИЯ ФУНКЦИИ ОДНОЙ ПЕРЕМЕННОЙ [Гл. J

метричный план [230]. Этот план начинается с двух симметричных

на [а, Ь] точек

u1 = a + -J^-(b-a)+ <~1>лр* е.и^а+Ь-и^

Если после k вычислений функции найден отрезок [аЛ, bk\ (А>1;

^ = 0, Ьг = Ь)9 содержащий точки и* и uk с вычисленным значени-

ем J(uk)= min J(ut)> то следующая точка берется так: Uk+\ =

^ufc + fyfe—wa и т- Д. После п вычислений получим отрезок [ап, Ьп],

и можем положить ип = "^ п . С ^помощью индукции нетрудно

доказать, что

Теперь можно ответить на вопрос: сколько следует произвести

.наблюдений значений J (и), чтобы с заданной точностью 6>0 оп-

ределить точку и* минимума /(M)eQ*[a, b\> Количество необхо-

димых для этого наблюдений равно наименьшему из чисел п, удов-

летворяющих неравенству

2Fn+1 Fn+i 2

Очевидно также, что гарантированная наименьшая возможная

-длина отрезка [аП9 Ьп], содержащего точку и* минимума J(u)^

^Q*[a, &], который может быть получен по наблюдениям значений

этой функции в п точках (п^2), задаваемых последовательно,

всегда больше 2бд (Ь — а) = —^—. Наконец, длина отрезка [а, Ь],

Fn+i

на котором с заданной точностью б>0 можно найти точку и* <ми-

нимума /(w)sQ*[a, b] по п наблюдениям значений J (и), меньше

§ 8. МЕТОД ЗОЛОТОГО СЕЧЕНИЯ

Описанные выше планы Фибоначчи являются эффективным

методом отыскания точки и* минимума функции 7(w)eQ*[a, b].

Однако, к сожалению, нельзя воспользоваться планами Фибонач-

чи, не зная заранее числа п предполагаемых наблюдений значений

■(функции, ибо выбор первых точек щ, и>2 в этих планах требует

.знания числа п. Между тем на практике встречаются ситуации,

когда число п по каким-либо причинам не может быть заранее

определено. Иногда желательно не ограничивать себя каким-то

наперед заданным числом л наблюдений значений J (и) и прово-

§ s]

Метод золотого сечения

33

дить наблюдения до тех пор, пока, не удовлетворится какой-либо

интересующий нас критерий, попутно стараясь, однако, чтобы ис-

пользуемый метод поиска по возможности скорее привел к точке

минимума. В этом случае можно пользоваться методом деления

отрезка пополам, не требующим знания числа п наблюдений зна-

чений J (и). Однако существует еще один метод, который также

не зависит от намечаемого числа п значений J (и) и который при

достаточно больших п почти столь же эффективен, как и метод

Фибоначчи. Это — метод золотого сечения [230].

Как известно, золотым сечением отрезка называется деление

отрезка на две неравные части так, чтобы отношение всего отрезка

к большей части равнялось отношению большей части к меньшей.

Нетрудно проверить, что золотое сечение отрезка [а, Ь] произво-

дится двумя симметрично расположенными точками

и1 = <Н -—(6—а) и и2=а+Ь — и± =

= а+ ~1 {Ь — а)> иг<и29

причем

±=± = ±=jL в ь~а = "*-" = 1±У£~ 1,618033989.

Ь — иг их — а иг — а Ь — и2 2

Замечательно здесь то, что точка и\ в свою очередь производит

золотое сечение отрч\зка [я, и2]: здесь

и2 — их<их — а = Ь — и2, — = —1 .

их — а и2 — U\

Аналогично точка а2 производит золотое сечение отрезка [ии Ь].

Опираясь на это свойство золотого сечения, можно предложить

следующий метод поиска точки и* минимума функции J(u)£ Q*[a, b].

А именно сначала на отрезке [а, Ь] берем точки иг и и2, задающие

золотое сечение отрезка [а, Ь] = [а19 Ьг]. Сравнивая J(ux) с J(u2)t

находим новый отрезок [aj, b2], а2<#*<62, причем

b2 — a2 = u2 — a = b — u1 = *Ъ~~ (Ь — а),

и на отрезке [а2, Ь2У находится точка и29 совпадающая с одной из

точек их или и2, в которой J (и2) = min J(щ) и производящая золо-

тое сечение отрезка [а2, Ь2]. Далее берем симметричную с и2 точку

из = а2 + Ь2 — и2, также производящую золотЬе сечение отрезка

[^2» Ь2]> вычисляя значение J(u3) и сравнивая его с J(u2), находим

34 МИНИМИЗАЦИЯ ФУНКЦИИ ОДНОЙ ПЕРЕМЕННОЙ [Гл. I

новый отрезок [а3, Ьь], я3<а*<&3, и т' Д- Пусть уже известен от-

резок

-*—^—J (6 — а) и известна

точка ил, ah<un<bn, производящая золотое сечение отрезка {ап> Ьп]

и ^совпадающая с одной из точек ul9 ut, ... , ип, в которой

J(un) — m\nJ-{Ui). Тогда в— качестве ип+\ возьмем точку

un+i = an + bn — иЛ, также производящую золотое сечение отрезка

[ал, Ьп]9 вычисляем значение J(Un+\) и, сравнивая с J(un), находим

новый отрезок

№п+1> Ьп+\], CLn+l < #* < Ьп+\,

и т.. д. Процесс продолжаем до тех пор, пока не получим и* с до-

статочной точностью или пока не выполнится другой интересующий

нас критерий.

Пусть мы остановились на /г-м шаге (п > 2) и нашли отрезок

[ап% Ья], ал<и*<6я, а также точку ил> ап<ип<Ьп, с вычислен,

ным значением /(wn) = min/(кЛ, производящую золотое сечение от-

резка [ал, &„]. Заметим, что для этого нам понадобилось п вычис-

лений^ значений функции. Если мы решаем задачу А, то полагаем

Un = ип с погрешностью

\и* — ип\<тах{Ьп — ип, ип — ап}= ( ~l )(fri — <**) =

Ь — а .

Если решаем задачу Б, то полагаем ип = * п с погрешно-

стью

§9]

Метод ломаных

35

Для сравнения с методами Фибоначчи для решения задач А и Б

заметим, что при больших п число

"V 2 ) ST'

/Г

Поэтому при достаточно больших п погрешность, получаемая при

применении метода золотого сечения к решению задач А и Б, боль-

ше соответствующей погрешности метода Фибоначчи всего в

/н^у_1_ 1708

V 2 J vt

раз. Отношение погрешности метода золотого сечения к погрешности

метода деления отрезка пополам при решении задачи А равно

/ 2/2" у

К2»(0,87...)«^2.

Отсюда видно, что уже при не очень больших п преимущество ме-

тода золотого сечения становится ощутимым.

На практике иногда сочетают метод золотого сечения с мето-

дом Фибоначчи: на первой стадии поиска минимума применяют ме-

тод золотого сечения, затем, задавшись некоторым натуральным

числом л, переходят к плану Фибоначчи Фп и на этом заканчива-

ют поиск.

Упражнение. Пусть заданы m чисел: а\, аг, ..., dm — и пусть

известно, что минимум minak=ap достигается при каком-то един-

ственном р, l^ip^m, причем а\^а2^ ... >аР, ap<ap+i<; ...^Om.

Как организовать п выборок из чисел а\9 аг, ..., а™, чтобы ар=

= mmak найти как можно точнее? Существует ли наилучшая стра-

тегия определения р?

§ 9. МЕТОД ЛОМАНЫХ

В этом параграфе рассмотрим один простой метод минимиза-

ции функций J (и), удовлетворяющих условию Липшица на отрез-

ке [а, &], позволяющий найти минимум с любой наперед заданной

точностью [85, 182]. Напомним

Определение 1. Говорят, что функция J (и) удовлетворяет

условию Липшица на отрезке Га, Ь\ если существует такая по-

стоянная L>0, что \J(u)—J(v) \^:L\u—'v\ при любых и, ue[fl, &].

Пользуясь -формулой конечных приращений Лагранжа, не-

трудно показать, что непрерывная на отрезке функция J (и) с ку-

сочно-непрерывной производной удовлетворяет условию Липшица

с константой L=sup|/'(w) |.

36 МИНИМИЗАЦИЯ ФУНКЦИИ ОДНОЙ ПЕРЕМЕННОЙ [Гл. 1

Зафиксируем произвольную точку v отрезка [а, Ь] и определим

функцию K(ut v)=J(v)— L\u—v\ переменной и, a^.u^.b. Нетруд-

но видеть, что функция К(и9 v) кусочно-линейна, K(vt v)=J(v)f

К(и, v)^J(u) при всех и, а^и^Ь.

Опишем метод ломаных. В качестве начального при*

ближения может быть взята любая точка u0£[at Ь]. Далее состав-

ляем функцию /С(и, и0) = J(и0) — L\и — и0\ и следующую точку иг

определяем из условия min/С (и, u0) = K(uv и0) (очевидно, их = а

или «! = &). Зная иь определяем К (и, и±)> составляем новую функ-

цию Рх(и) = max К (и, ut) и находим и2 из условия Рг(и2) = min Рг{и)

i=0,l а^и^Ь

(рис. 4). Пусть точки u0t и19 ... , ид(л>1) уже известны. Тогда

составим функцию

Рп(и) = max/С (я, щ) = max {/([(и, ип), Рп-\{и))

(примем Р0(и) = К(и% и0)) и следующую точку ип+\ найдем из усло-

вия Рп (un+i) = min Рп (и) и т. д. Если min Рп (и) достигается в

нескольких точках, то в каче-

стве ип+х берем любую из

них.

Для доказательства сходи-

мости этого метода нам пона-

добятся следующие свойства

Рп(и)9п=0, 1,2,...: 1) Рп(и) —

непрерывная кусочно-линейная

функция и график ее представ-

ляет собой ломаную линию,

состоящую из отрезков пря-

мых с угловым наклоном L

или — L\ 2) Рп(и)^Рп+\(и)у

Pn(u)^J(u) при любых

и, а^и^Ь и любых я=0, 1,

2,...; 3) Pn(Ui)=J(Ui) при

всех * = 0, 1,..,п, ибо J(Ui) =

=K(uiy Ui)^Pn(Ui) < J{Ui);

4) Pn(u) удовлетворяет усло-

вию Липшица на отрезке

[а, Ь] с константой L.

А

4

1 а /

К

в

г%

у

и

В

)4f

• •>

U2U!

А

\°'и,

\

с

ХЪС - график функции K(u,uJ,

А В, - график К (и ,uf), А ВС.в^график

Р,(и), А2ВгСг-график К (и,иг)МЪ?Ь?£2^-

график Р2(и)

Рис. 4

Теорема 1. Построенная выше последовательность {ип} та-

кова, что: 1) lim Pn(Wn+i)=/*==inf/(H) =/(*/*); 2) любая пре-

* 91

Метод ломаных

37

дельная точка и последовагельностгг {ип} является точкой мини-

мума функции J (и); 3) если J (и) достигает своего минимума на

отрезке [а, Ь] в единственной точке а*, то вся последовательность

{ип} сходится к а*.

Доказательство. Прежде всего заметим, что последователь-

ность Pn(tin+\) монотонно возрастает и ограничена сверху;

Рп-х (йп) = min/V-! (и)]< Pn-i (un+i) < Рп (ил-н),

Рп (и^,) = min Рп (и) < />„ (и') < J (и*).

Следовательно, существует UmPnr{un+i) = P\<J*. Покажем, что

Р* = J\ Пусть и — произвольная предельная точка последовательно-

сти {и„}. Тогда существует подпоследовательность^^}, сходящая^к

и, причем можем считать, что Л<л2< • •• <[я*Он-1<3 Так

как

О < J (щ) — Рп (un+i) «= Рл (и,) — Рп («„+!) < I | и, — «д+il

при. любом п и любых t, 0< *<[/*, то полагая здесь 1 = л*_ь

n=nk — 1, получим 0<J(urtfr-1)—Pn^^XLI^^—>nft|. От-

сюда при k ->- оо имеем

У < / (в) = lim/ (i^) - lim Pftj._, (ипЛ = P* < Л

*->oo fc-»oo " ■

т. e. hmPn(un+i) = J* = J(u).

Л-*оо

Первое и второе утверждения теоремы доказаны. Третье утверждение

теоремы теперь является простым следствием первых двух. А

Описанный метод ломаных имеет ряд достоинств. Он позволя-

ет получить приближенное значение точки абсолютного минимума

функции J (и) на [а, 6] и сходится при любом выборе начальной

точки щ, лишь бы функция J (и) удовлетворяла условию Липшица.

Метод ломаных не требует существования производной J'(u) во

всех точках отрезка, наличия строгой квазивыпуклости /(w), кро-

ме того, функция J (и) может иметь сколько угодно локальных и

абсолютных минимумов на отрезке [а, Ь]. Если константа Липшица

L функции J (и) известна, то метод ломаных прост и удобен для

использования на ЭВМ. На каждом шаге этого метода требуется

решить простую задачу минимизации кусочно-линейной функции

Рп(и), сводящейся к перебору известных вершин ломаной Рп(и),

причем перебор здесь существенно упрощается, ибо ломаная Рп (и)

отличается от Pn_i(a) не более чем двумя новыми вершинами.

38 МИНИМИЗАЦИЯ ФУНКЦИЯ ОДНОЙ ПЕРЕМЕННОЙ [Гл. 1

Нетрудно модифицировать-описанный метод ломаных так, чтобы

последовательность Pn(un+i) строго монотонно возрастала.

В работе [83] показано, что метод ломаных близок к опти-

мальным методам поиска минимума на классе функций, удовлет-

воряющих условию Липшица. Оптимальная стратегия поиска ми-

нимума строго квазивыпуклых функций, удовлетворяющих усло-

вию Липшица, рассмотрена в работе [241].

§ 10. ВЫПУКЛЫЕ ФУНКЦИИ. МЕТОД КАСАТЕЛЬНЫХ

Для минимизации некоторых классов функций можно исполь-

зовать более эффективные варианты метода ломаных. Опишем

одну модификацию метода .ломаных, пригодную для поиска мини-

мума выпуклых функций, когда в качестве звеньев ломаных бе-

рутся отрезки касательных к графику функции.

Определение 1. Функция J (и), определенная на. отрезке

а^и^Ь, называется выпуклой, если

J(au + [l — a]v)<aJ(u) + (\—a)J{v) (1)

при всех и, v£[a> b] и всех а, 0<а<1.

Когда а пробегает отрезок [0, 1], точки (aw+(l—a) v, aJ(u) +

+ (1— a)J(v)) на плоскости переменных (u9J) пробегают хордуЛВ,

соединяющую точки А=,(и, J(u)) и В= (и, J(v)) на графике

функции. Поэтому неравенство (1) имеет простой геометрический

смысл: график выпуклой функции на любом отрезке '[и, t>]s[a,.ft]

находится ниже хорды, соединяющей точки графика функции на

концах отрезка [и, v]. Примерами функций, выпуклых на любом

отрезке из области своего определения, могут служить следующие

элементарные функции: и2, и, —иу |к|, eu, erw, —1шг. Функция

sinw выпукла на отрезке — яг^и^О и невыпукла при О^и^л.

Более подробное изучение выпуклых функций отложим до сле-

дующей главы, а здесь отметим лишь некоторые свойства выпук-

лых функций, необходимые для описания метода касательных

(см. также упражнения в конце настоящего параграфа).

Теорема 1. Пусть функция J (и) выпукла и непрерывно диф-

ференцируема на отрезке [а, Ь]. Тогда: 1) справедливо неравенство

J(u)>J(v) + J'(v)(u-v) (2)

при всех w, ye[a, b] (иначе говоря, график гладкой выпуклой

функции лежит выше графика любой ее касательной); 2) произ-

водная Г (и) не убывает на [а, &]; 3) J (и) удовлетворяет на [a, Ь]

условию Липшица с константой L=max{|/'(a+0) |, |/'(6—0) |}.

§ т

Выпуклые функции. Метод касательных

39

Доказательство. Перепишем неравенство (1) в виде

J(v-\-a(u—v))—J(v)^a[J(u)—J(v)]. К левой части этого неравен-

ства применим формулу Лагранжа о конечных приращениях. По-

лучим

•/'(о + бсф — v))a(u— v)<£a[J(u) — J (v)], 0<6<1,

или

J'(v + fa(u — v))(u — v)<J(u) — Jm(v)

при всех 0 < а < 1. Отсюда при а -► + 0 сразу придем к неравен-

ству (2).

Переменные и и v в (2) .равноправны. Меняя их ролями, по-

лучим j(v)^J(u)+J'(u)(v—и) при всех и, иё[а, Ъ\ Сложим по-

следнее неравенство с (2) почленно. Будем иметь [J'(u)—/'(у)]

(и—v)^0 при всех и, v^[ay Ь\ что равносильно неубыванию про-

изводной J'(u) на отрезке [а, Ь]. Следовательно, /'(а+0Х/'(и)<

J'(b—0) при всех и, а^и^Ь. С помощью формулы Лагранжа о

конечных приращениях отсюда имеем

\J(u)-J(v)\=\J'(t)(u-v)\<L\u-v\

при всех и, v£[a, b], где a<£<6, L = тахШ' (а + 0)|,

№ (6-0)|}. А

Обозначим через U* множество точек глобального минимума

функции J (и) на отрезке [а, Ь\ т. е. U*={u: a^zu^b, J(u) =

=/* = inf/(H)}. Возможны следующие три случая: 1) U* — пус-

тое множество (примером такой функции может служить J(u)=u

при 0<к^1, /(0) = 1 на отрезке [0, 1]); 2) О* состоит из одной

точки и* (примером служит функция J(u)=u2 на отрезке [—1,1]);

3) U* состоит более чем из одной точки (примером служит J(u) =

= \и\ + \и—1| на отрезке fc-4, 2]). В последнем случае существу-

ет отрезок (р, у]^[а, 6], все внутренние точки которого принадле-

жат £/*, а концы этого отрезка могут и не принадлежать U* (при-

мер: /(w)s=0 при 0<а^1, /,(0) = 1). В самом деле, если и* и и*е

el/*, u*^v*9 то

/*</(aa*+(ll— a)u*X<x/(tt*) + (l— a)J(v*)=J*

Следовательно, /(aa*+(l—a)u*)=/* при всех ae[0, 1], т. е. весь

отрезок [a*, i>*]c:C/*. Теперь остается взять p=inf£/*, y=suP^*- А

Теорема 2. Всякая выпуклая на отрезке [а, &] функция J (и),

достигающая своей нижней грани на этом отрезке, принадлежит

подмножеству Q*[a, b] строго квазивыпуклых функций на [а, Ь].

Доказательство. По условию U* непусто. Обозначим

P=inf£/*, Y=sup[/*. Как было замечено выше, либо U* состоит

из одной точки и.* и тогда р=у=и*, либо P<y и тогда все точ-

ки интервала p<w<v принадлежат U*9 т. е. /(и)=/* при Р<м<

40 МИНИМИЗАЦИЯ ФУНКЦИИ ОДНОЙ ПЕРЕМЕННОЙ [Гл. t

<у. Далее, если а<р, то 1(ц) строго монотонно убывает при а<

<w<p и Нт/(ы)=/(р)=/*, ибо в противном случае, как нетруд-

«-►Э—о

но видеть, функция J (и) не может быть выпуклой на [а, Ь]. Анало-

гично, если у<.Ь, то J (и) строго монотонно возрастает при у<.и<.

[<Ь и UmJ(u)=J(y)=J*. Таким образом, 7(«)eQ*[a, &]. А

Пусть функция J (и) выпукла и непрерывно дифференцируема

на отрезке (а, Ь\ Согласно теореме* 2/(и) принадлежит Q*[af b\.

Опишем метод касательных для ее минимизации. Через L(u, v)

будем обозначать линейную функцию L(ut v)==J(v)-\-J'(v)(u—v)

переменной и, a^.u^:b при каждом фиксированном v^[a9 b]. В си-

лу теоремы 1 J(u)^L(uy v) при всех ме[а, 6]. В качестве началь-

ного приближения может быть взята любая точка Wo^fa, b\ Далее

составляем функцию L(u, щ) и следующую точку щ определяем

из условияminL (utUo)=L(u\tUo) (очевидно и\=а или U\=b).

Пусть Г(ио)ФО, ибо если /,(^о)=0, то, как следует из нЪравей-

ства (2) при у=Оо, точка tio будет точкой минимума, и процесс на

этом прекращается. Зная ии определяем L(u9u\)9 составляем но-

вую функцию Pi (и) =maxL (а, щ) и находим щ, из условия Р\ (и2) =

=minPi(u) (рис. 5). Пусть точки щу ии ..., Un (n^l) уже извест-

J

0

АВ-график функции Ни ип)

CD -график Ltu.u,),AED -график

P,(u).PQ -график L(u,u9) AMND-

график Р2(и)

Рие. 5

ны и Г(ип)Ф0 1(если J'(un)=0, то из (2) при v=un следует, что

tin — искомая точка минимума). Тогда составляем функцию

Рп(и) = max L (w, ul) = max{L(u9 ип), P,*-i(tt)}

(естественно принять P0(u) = L(u, и0))> и следующую точку ип+\

находим из условия Рп (ип+\) = min Рп (и) и т. д.

§ т

Выпуклые функции. Метод касательных 41

Нетрудно видеть, что Рп(и) —непрерывная кусочно-линейная

функция, и график ее представляет собой ломаную-, состоящую из

отрезков касательных к графику функции J (и). Поэтому описан-

ный метод естественно назвать методом касательных.

Теорема 3. Пусть функция J (и) выпукла и непрерывно диф-

ференцируема на отрезке [а, 6], и пусть построенная выше после-

довательность {ип} такова, что 1'(ип)ф0, п=0, 1, Тогда:

1) НтРя(М = ^= inf П")\

2) последовательность {tin} имеет не более двух предельных

точек, совпадающих с и*=тШ*, w**=sup£/*, где U* — множест-

во точек минимума J (и) на [а, Ь]. Если U* состоит из одной точки

и*, то limun=:w*.

П->оо

Доказательство. Заметим, что при выполнении условий

теоремы функция J (и) удовлетворяет условию Липшица с кон-

стантой L=max{|/'(a) |, \У(Ь)\) (см. теорему 1). Кроме того,

согласно неравенству (2) L(uf un)^J(u) при всех и^[а, Ь] и всех

п=0, 1, Тогда ломаная Рп(и), построенная из отрезков каса-

тельных указанным выше способом, обладает свойствами 1)—4),

сформулированными перед теоремой 9.1. Поэтому буквальным пов-

торением доказательства теоремы 9.1 можно убедиться, что любая

предельная точка, последовательности {ип} принадлежит множест-

ву U*. Однако J (и) непрерывна и строго квазивыпукла на [а, 6],

поэтому О* либо представляет собой отрезок а*^м^|ц**, либо

состоит из единственной точки а*. По условию 1'(ип)ф0 и, сле-

довательно, Un$EU*. Тогда предельными для последовательности

{ип} могут быть лишь точки и* или ы**, а в случае и*=и** имеет

место равенство limun=u*. А

П-»оо

При описании метода касательных выше предполагалось суще-

ствование производной J'(u) во всех точках we[a, b]. Однако этот

метод может быть приспособлен для поиска минимума любой вы-

пуклой функции на отрезке [а, &], лишь бы она достигала своей

нижней грани на этом отрезке. Дело в том, что выпуклая на [a, Ь]

функция во всех внутренних точках этого отрезка непрерывна,

имеет конечные левые и правые производные

J'(u + 0)=Um '<» + *>-■'<"> f

J'(u-0)= lim Hu)-J(u-h) f

, Л-Ч-0 h

причем У (и—0)^:J'(u+0) (см. ниже упражнение 2). Поэтому в

описанном выше методе касательных можно принять L(u, ип) =

=J(ttn)+J'n* (и—tin) у где Jn — произвольная постоянная, удовлет-

42 МИНИМИЗАЦИЯ ФУНКЦИЙ ОДНОЙ ПЕРЕМЕННОЙ [Гл. I

воряющая неравенствам У(ип—0) <;/п^/'("п+0); неравенство

J(u)^L(u; ип)> а^и^Ь, при этом сохранится (см. упражнениеЗ).

На практике удобнее брать Уп из условия |/д| =min{|//(wn—0) |,

\J'(Un+0) |}. Если при некотором п окажется, что J'(un—0)^0^

^'/ (йп+0), то Wn — точка минимума (см. упражнение 4), и в

этом случае процесс прекращается. Чтобы избежать возможных

равенств //(а+0)=—оо или J'(b—0)=+оо, удобно начинать про-

цесс поиска с точек Uo=a+ho и щ = Ь—к\ с тем, чтобы следующее

приближение м2 взять из условия минимума Р2(и) = max{L(w, и0);

L(u, Ui)}. Здесь Ао, h\— положительные величины, выбираемые

из условия, чтобы /'(a+fto+О) и J'(b—h\—0) помещались в раз-