Автор: Волков И.К. Зуев СМ. Цветкова Г.М.

Теги: анализ теория вероятностей математическая статистика комбинаторный анализ теория графов математика учебник для вузов

ISBN: 5-7038-1267-4

Год: 1999

И.К. Волков, СМ. Зуев, Г.М. Цветкова

СЛУЧАЙНЫЕ

ПРОЦЕССЫ

Под редакцией

д-ра техн. наук., профессора B.C. Зарубина

и Д-ра физ.-мат. наук, профессора А.П. Крищенко

Рекомендовано Министерством общего

и профессионального образования

Российской Федерации

в качестве учебника для студентов

высших технических учебных заведений

Москва

Издательство МГТУ им. Н. Э. Баумана

1999

УДК 517.1

ББК 22.171

В67

Рецензенты: проф. В.Н. Новосельцев, проф. И.Б. Погожев

В67 Волков И.К., Зуев СМ., Цветкова Г.М. Случайные

процессы: Учеб. для вузов / Под ред. B.C. Зарубина, А.П. Кри-

щенко. - М.: Изд-во МГТУ им. Н.Э. Баумана, 1999. -448 с.

(Сер. Математика в техническом университете; Вып. XVIII).

ISBN 5-7038-1267-4 (Вып. XVIII)

ISBN 5-7038-1270-4

Книга является восемнадцатым выпуском учебного комплекса „Мате-

„Математика в техническом университете", состоящего из двадцати выпусков,

и знакомит читателя с основными понятиями теории случайных процес-

процессов и некоторыми из ее многочисленных приложении. По замыслу авто-

авторов, данный учебник должен явиться связующим звеном между строгими

математическими исследованиями, с одной стороны, и практическими за-

задачами — с другой. Он должен помочь читателю овладеть прикладными

методами теории случайных процессов.

Содержание учебника соответствует курсу лекций, который авторы

читают в МГТУ им. Н.Э. Баумана.

Для студентов технических университетов. Может быть полезен

преподавателям и аспирантам.

Ил. 34. Библиогр. 30 назв.

Выпуск книги финансировал

Московский государственный технический

университет им. Н.Э. Баумана

УДК 517.1

ББК 22.171

© И.К. Волков, СМ. Зуев,

Г.М. Цветкова, 1999

@ Московский государственный

технический университет

ISBN 5-7038-1267-4 (Вып. XVIII) им' НЭ' ВаУмана-1999

ISBN 5-7038-1270-4 © Издательство МГТУ

им. Н.Э. Баумана, 1999

ПРЕДИСЛОВИЕ

Теория случайных процессов — интенсивно развивающийся

раздел теории вероятностей, имеющий многочисленные при-

приложения в физике, технике, биологии, медицине, экономике и

других областях знаний. Для овладения методами этой тео-

теории нужны знания не только в объеме базового курса высшей

математики и традиционных разделов курсов теории вероят-

вероятностей и математической статистики, но и ряда специальных

курсов. В частности, мы предполагаем, что читатель может

оперировать основными понятиями теории дифференциальных

уравнений математической физики, а также владеет методами

теории интегральных преобразований.

Ориентируясь на студентов технических вузов, инженеров

и научных сотрудников прикладных специальностей, мы ста-

старались вести изложение на доступном уровне, отступая иногда

от строгого математического стиля. В основном, этот подход

использован при анализе различных задач прикладного харак-

характера, если содержательный смысл их решений интуитивно ясен.

Естественно, что в одной книге невозможно охватить все

основные разделы теории случайных процессов и, тем более,

все ее приложения. По замыслу авторов, данный учебник

должен помочь читателю овладеть прикладными методами

теории случайных процессов и явиться связующим звеном

между строгими математическими исследованиями, с одной

стороны, и практическими задачами — с другой.

Надеемся, что книга будет полезна студентам, аспирантам,

научным сотрудникам и не только технических специально-

специальностей.

В начале книги (после предисловия и введения) помещен

список основных обозначений, содержащих расшифровку часто

встречающихся в тексте символов. В большинстве математи-

6 Предисловие

ческих символов использованы буквы латинского и греческого

алфавитов, написание и произношение которых представлены

после списка основных обозначений.

В конце книги приведен список рекомендуемой литерату-

литературы и предметный указатель, в который входят в алфавитном

порядке (по существительному в именительном падеже) все вы-

выделенные в тексте полужирным курсивом термины. Для

каждого термина указан номер страницы книги, на которой

он определен и выделен полужирным курсивом, или номер вы-

выпуска, в котором дано его объяснение. Выделение термина

светлым курсивом означает, что в данном параграфе он явля-

является одним из ключевых слов и читателю должно быть знакомо

значение этого термина. Читатель может уточнить это зна-

значение, найдя при помощи предметного указателя необходимую

страницу. Ссылки на другие источники даны либо путем указа-

указания номера выпуска, либо путем упоминания фамилий авторов,

по которым можно определить полные данные этих источников,

обратившись к списку рекомендуемой литературы.

Ссылки в тексте на номера формул и рисунков набраны

обычным шрифтом (например, A0.4) — четвертая формула в

десятой главе, (П2.9) — девятая формула во втором приложе-

приложении, (рис. 9.2) — второй рисунок в девятой главе).

Прежде чем приступать к изучению теории случайных про-

процессов, мы предлагаем читателю ответить на вопросы для

самопроверки и убедиться в том, что он готов к усвоению

излагаемого материала. В конце каждого вопроса римскими

цифрами обозначен содержащий соответствующий материал

номер выпуска комплекса учебников „Математика в техниче-

техническом университете".

Задания для самопроверки

1. Что понимают под множеством? Какие множества на-

называют: а) конечными; б) счетными; в) несчетными? Что

называют диаметром множества в метрическом простран-

стве? Что называют: а) объединением множеств; б) пере-

пересечением множеств; в) разностью множеств; г) допол-

дополнением множества? [I]

2. Дайте определение отображения (функции). Что

называют: а) образом множества X при отображении /;

б) прообразом множества при отображении /? [I]

3. Какие функции называют: а) четными; б) нечетными;

в) периодическими; г) тригонометрическими? Запишите

формулы Эйлера и докажите основные свойства тригономе-

тригонометрических функций. [I], [IX]

4. Что называют: а) скалярной функцией векторного

аргумента; б) вектор-функцией; в) векторной функци-

функцией векторного аргумента; г) координатной функцией;

д) бесконечно малой функцией? Как сравнивают бесконеч-

бесконечно малые функции? [I], [II], [V]

5. Дайте определение предела: а) последовательности;

б) функции. Сформулируйте признаки существования преде-

предела. Перечислите свойства функций, имеющих конечный пре-

предел. [I], [V]

6. Какую функцию называют непрерывной: а) в точке;

б) на множестве? Перечислите основные свойства функций,

непрерывных: а) в точке; б) на множестве. [I], [V]

7. Дайте определение дифференцируемой функции:

а) в точке; б) в области. Что называют частной производ-

производной от скалярной функции векторного аргумента? Приведите

формулировку теоремы о равенстве смешанных производ-

ных. [II], [V]

8. Для скалярной функции векторного аргумента запишите

формулу Тейлора и сформулируйте условия ее применимо-

применимости. [V]

9. Дайте определение локального экстремума (макси-

(максимума и минимума) скалярной функции векторного ар-

аргумента. Сформулируйте необходимые и достаточные усло-

условия его существования. [V]

Предисловие

10. Дайте определение касательной плоскости к по-

поверхности в заданной точке. При каких условиях касательная

плоскость существует? [V]

11. Что называют определенным интегралом и какой

геометрический смысл он имеет? Запишите формулу ин-

интегрирования по частям. Дайте определение те-кратного

интеграла. [VI], [VII]

12. Что называют матрицей и что понимают под разме-

размером матрицы? Какую матрицу называют: а) квадратной;

б) единичной; в) нулевой или нуль-матрицей; г) симме-

симметрической; д) диагональной; е) трехдиагональной; ж) не-

невырожденной; з) блочной; и) положительно определен-

определенной; к) неотрицательно определенной; л) ортогональ-

ортогональной? [III], [IV]

13. Сформулируйте основные свойства следующих опера-

операций над матрицами: а) сложение матриц; б) умножение

матрицы на число; в) умножение матриц; г) транспони-

транспонирование матрицы. Дайте определение обратной матрицы

и укажите ее основные свойства. Какие матрицы называют

коммутирующими (перестановочными)? [III]

14. Что понимают под следом SpA матрицы А1 Докажи-

Докажите следующие равенства, полагая, что все указанные матрицы

квадратные одного порядка, а матрица D невырожденная

симметрическая и имеет собственные числа Ajt (k=l,n):

a) Sp(A + B) = Sp{A) +Sp(B); б) Sp{AC) = Sp(CM); в) Sp{Dm) =

= t A?, m e N; r) Sp(D~l) = ? A;1. [Ill], [IV]

k=\ k=\

15. Дайте определение системы линейных алгебраиче-

алгебраических уравнений. Какую систему линейных алгебраических

уравнений называют совместной? Сформулируйте условия

существования и единственности решения системы линей-

линейных алгебраических уравнений. [III]

16. Дайте определение линейного пространства. Что

называют: а) линейной оболочкой системы векторов ли-

линейного пространства; б) линейно (не)зависимой системой

векторов линейного пространства; в) базисом линейного

пространства; г) размерностью линейного простран-

пространства? [IV]

17. Что понимают под скалярным произведением в

линейном пространстве и что называют евклидовым про-

пространством? Можно ли утверждать, что любое линейное

пространство со скалярным произведением является нор-

нормированным пространством? Дайте определение орто-

нормированного базиса евклидова пространства и запишите

формулу для скалярного произведения в этом базисе. [IV]

18. Запишите неравенство Коши — Буняковского. В

каких случаях это неравенство обращается в равенство? [IV]

19. Что называют квадратичной формой? В каких слу-

случаях квадратичную форму называют: а) положительно

определенной; б) отрицательно определенной; в) неполо-

неположительно определенной; г) неотрицательно определен-

определенной? Изложите принципиальную схему приведения квадратич-

квадратичной формы к каноническому виду с помощью ортогональ-

ортогонального преобразования. [IV]

20. Дайте определение линейного оператора. Какая

связь существует между линейными операторами и матрица-

матрицами? Дайте определение собственного вектора и собствен-

собственного значения линейного оператора. Изложите общую

схему их нахождения. [IV]

21. Что называют линейным дифференциальным опе-

оператором и обыкновенным линейным дифференциаль-

дифференциальным уравнением? Дайте определение фундаментальной

системы решений обыкновенного линейного дифференциаль-

дифференциального уравнения. [VIII]

22. Сформулируйте задачу Коши для: а) обыкно-

обыкновенного дифференциального уравнения те-го порядка;

б) системы обыкновенных дифференциальных уравне-

уравнений первого порядка; в) системы уравнений в част-

частных производных параболического типа. Сформулируй-

10 Предисловие

те теоремы существования и единственности решения этих за-

дач. [VIII], [XII]

23. Что называют дифференциальным уравнением в

частных производных: а) параболического типа; б) эл-

эллиптического типа; в) гиперболического типа? [XII]

24. Что понимают под смешанной задачей для урав-

уравнения в частных производных параболического типа?

Изложите идею метода Фурье разделения переменных для ре-

решения смешанных задач. Сформулируйте задачу Штурма —

Лиувилля. [XI], [XII]

25. Дайте определение устойчивости и асимптотиче-

асимптотической устойчивости решения задачи Коши для системы

обыкновенных дифференциальных уравнений первого

порядка. [VIII]

26. Что называют: а) интегральным преобразованием;

б) оригиналом интегрального преобразования и его изо-

изображением; в) интегральным преобразованием Фурье;

г) интегральным преобразованием Лапласа; д) сверткой

оригиналов? Сформулируйте условия представимости функ-

функции интегралом Фурье. [XI], [IX]

27. Дайте определение числового ряда. Какой числовой

ряд называют: а) знакоположительным; б) знакочереду-

знакочередующимся; в) знакопеременным; г) сходящимся; д) сходя-

сходящимся абсолютно; е) сходящимся условно? [IX]

28. Дайте определение функционального ряда. Какой

функциональный ряд называют: а) сходящимся; б) абсо-

абсолютно сходящимся; в) равномерно сходящимся? Перечи-

Перечислите основные свойства функциональных рядов, сходящихся:

а) абсолютно; б) равномерно. [IX]

29. Что называют рядом Фурье функции f(x) в L2[o,6]?

Сформулируйте условия Дирихле поточечной сходимости

тригонометрического ряда Фурье. Что называют: ор-

тонормированной тригонометрической системой функ-

функций? [IX]

и

30. Что понимают под: а) аппроксимацией; б) абсолют-

абсолютной погрешностью аппроксимации; в) относительной

погрешностью аппроксимации? [XIII]

31. Запишите: а) формулу полной вероятности; б) фор-

формулу Байеса. Дайте определение полной группы собы-

событий. [XVI]

32. Какую случайную величину называют случайной

величиной, распределенной по: а) нормальному зако-

закону; б) закону Пуассона; в) экспоненциальному закону;

г) равномерному закону; д) логарифмически нормаль-

нормальному закону; е) закону „хи-квадрат"; ж) закону Стью-

дента? [XVI], [XVII]

33. Приведите определения начальных и центральных

моментов случайной величины. Для моментов первого

и второго порядков приведите содержательную интерпрета-

интерпретацию. [XVI]

34. Дайте определение сходимости последовательности

случайных величин: а) по вероятности; б) почти навер-

наверное (или сильно); в) в среднем квадратичном. [XVI]

35. Что понимают под: а) случайными и систематиче-

систематическими ошибками измерений (наблюдений); б) реализа-

реализацией случайной величины; в) выборочной статистикой?

Как определяется: а) выборочное среднее; б) выбороч-

выборочная дисперсия; в) исправленная выборочная дисперсия;

г) выборочная ковариация? [XVII]

36. Дайте определение оценки числовой характеристи-

характеристики случайной величины, полученной по данным случайной

выборки. Как можно оценить ее качество? [XVII]

37. Что называют статистической гипотезой? Изло-

Изложите общую схему проверки любой статистической гипоте-

гипотезы. [XVII]

ОСНОВНЫЕ ОБОЗНАЧЕНИЯ

¦4 и > — начало и окончание доказательства

# — окончание примера, замечания

Е — множество действительных чисел 1-1.3

С — множество комплексных чисел 1-4.3

N — множество натуральных чисел 1-1.3

Z — множество целых чисел 1-1.3

Е" — (декартово) произведение п множеств действитель-

действительных чисел 1-2.5

Mnm(R) — множество матриц типа п х т с элементами из Е

III

М„(Е) — множество квадратных матриц порядка п с элемен-

элементами из Е III

/„, Е — единичная матрица в Мп(Ш) III

О — нуль-вектор в Е" IV

9т, в — нулевая матрица в Мпт(Ш) III

а ? А — элемент о принадлежит множеству А 1-1.1

а ? В — элемент о не принадлежит множеству В 1-1.1

iat}iLi — множество из элементов oi, 02, ..., адг 1-1.1

А — {х: ...} — множество А состоит из элементов х, обладаю-

обладающих свойством, указанным после двоеточия 1-1.1

Ad В — множество А является подмножеством множества В

(А включается в В) 1-1.2

— разность множеств А и В 1-1.4

— объединение множеств А\, А2, ..., А^ 1-1.4

л\

N

м

N

п

а =

В

Ах

^C

пересечение множеств А\, А2, ..., А^ 1-1.4

из высказывания а следует C (если а, то /3) 1-1.5

a <—> ft — высказывания а и (З равносильны (а тогда и только

тогда, когда/3) 1-1.5

V и Л — символы дизъюнкции (а V /3 читается: а или 0) и

конъюнкции (аЛ/3 читается: а и /3) 1-1.5

—>ot — отрицание высказывания а (не а) 1-1.5

Vz — для любого х 1-1.5

Зх : ... — существует такое х, что ... 1-1-5

$х : ... — не существует такое х, что ... 1-1.5

= — равно по определению 1.1

/: X —> Y — отображение / множества X в (на) множест-

множество Y 1-2.1

U(xo,e) — ^-окрестность точки xq I-5.2

N

J2 ак — сумма слагаемых alt a2, ..., aw 1-2.6

N

Yl o-k — произведение ./V сомножителей aj, a2, ..., aw 1-2.6

k=i

k=l,N — число к принимает последовательно все значения

из множества натуральных чисел от 1 до N включи-

включительно 1-2.6

х —>• a — переменное х стремится к a I-2.7

(a, 6) — скалярное произведение элементов а и 6 в евклидо-

евклидовом пространстве IV

||а|| — евклидова норма элемента а в евклидовом простран-

пространстве IV

o(h) — величина, более высокого порядка малости, чем h

1-10.1

argmax/(x) — значение аргумента функции f(x), при кото-

ром достигается тах/(х), или решение уравнения

f(y) = тах/(х) относительно у ? В 9.6

хеВ

S(x) — (J-функция Дирака XII

J(x) — единичная функция (функция Хевисайда) XI

14 Основные обозначения

А — матрица, транспонированная к матрице А III

А — матрица, обратная к матрице А III

RgA — ранг матрицы А III

detA, |Л| — определитель матрицы А III

diag(ai, ..., оп) — диагональная матрица с диагональными

элементами oi, ..., оп III

SpA — след матрицы А IV

а* — число, комплексно сопряженное к числу о 1-4.3

(?1,А,Р) — вероятностное пространство XVI, П1

Q — пространство элементарных событий XVI, П1

и — элементарное событие (исход) XVI, П1

Р[а] — вероятность события а XVI, П1

(Х,В) — измеримое пространство П1

?(и>) — случайная величина XVI, П1

F^(x) — функция распределения вероятностей случайной ве-

величины ?(и) XVI, П1

fo(x) - плотность распределения (вероятностей) случайной

величины f (w) XVI, III

)] — математическое ожидание случайной величины

f (w) XVI, П1

] — дисперсия скалярной случайной величины f(w) XVI,

П1

cov[?(lj);t](u>)] — ковариация скалярных случайных величин

?(w) и т}(ш) XVI, П1

р[€iw)'irl(UJ)] ~ коэффициент корреляции скалярных случай-

случайных величин f (w) и r}{u) XVI, П1

?f, cov[^(ol>)] — ковариационная матрица случайного вектора

f (ш) XVI, П1

Fe(x\y) = Fe(x\T)(u}) = у) — условная функция распределения

(вероятностей) случайной величины ?(<*>) при усло-

условии ф) = у, где е(ш) ± (fT(w) r)T(u))T XVI, П1

15

fe(x\y) = f?(x\ri(u>) = у) — условная плотность распределения

(вероятностей) случайной величины ?(w) при усло-

условии т}(ш) = у, где е(ш) = (fT(w) ^иГ XVI, П1

M[f(w)|y)] = М[?(и>)\г}(и>) = у] — значение условного матема-

математического ожидания случайной величины ?(w) при

условии rj(u>) = у XVI, П1

M[?(cj)|;7(cj)] — условное математическое ожидание случайной

величины ?(ш) при условии г}{ш) XVI, П1

D[?(w)|y)] = D[?(w)|;7(w) = у] — значение условной дисперсии

случайной величины ?(w) при условии т)(ш) = у

XVI, П1

D[?(cj)|;7(cj)] — условная дисперсия случайной величины ?(w)

при условии т)(и) XVI, Ш

?(t,uj), t € Т, — случайная функция 1.1

?(t,u), t Е Т = [а, 6], — случайный процесс 1.1

?(t,u), t е Т — N, {^k(^)}^Li — случайная последовательность

1.1

i^(a;|t) — одномерная функция распределения случайного про-

процесса ?(t,и), teT 1.1

f((x\t) — одномерная функция плотности вероятностей слу-

случайного процесса ?(?,и), t G Т 1.1

...,a;(jy)|ti,...,fjv) — /V-мерная функция распределения

случайного процесса f(?,u>), t e T 1.1

:B(N)l*ii'"i*Jv) — /V-мерная функция плотности ве-

вероятностей случайного процесса ?(t,w), t ? Т 1.1

— математическое ожидание случайного процесса

Z(t,uj),teT 1.2

— ковариационная матрица случайного процесса ?(i,tj),

teT 1.2

— дисперсия случайного процесса f (?,w), teT 1.2

) — ковариационная функция случайного процесса

?(t,w), *еГ 1.2

16 Основные обозначения

\,t2) — взаимная ковариационная функция случайных

процессов ?(i,o>), t ? Т, и r)(t,Lj), t ?T 1.2

>)||с/< — СК-нормаслучайного процесса ?(i,o>), t?T 3.1

lim ?(t,ij) — предел (в смысле СК-сходимости) случайного

'~**° процесса f(i,w), te Т, при i->• ?0 (*о е Т) 3.1

lim ?/то>(?,^) — предел (в смысле СК-сходимости) последова-

тельности случайных процессов {?(m)(?,^),? GTjJ^Li

3.1

?(t,Lj),t G 7о С Т — производная случайного процесса ?(i,o>),

* е т, в г0 с т з.з

f (p(t,t')?(t',u})dt' — интеграл от случайного процесса ?(t,u)),

т t G Т, с весовой функцией </>(?,?') по Т 3.4

?<[?(?,а>)] — результат воздействия линейного оператора Lt на

случайный процесс ?(i,o>), i G T 3.5

^(^) — спектральная плотность стационарного скалярного

случайного процесса ?(t,u), t ?T = [0,оо) 4.2

{Sfc}?=1 — множество возможных состояний марковского про-

процесса с дискретными состояниями 5.1

sJk — случайное событие, состоящее в том, что после j

этапов исходная система 5 находится в состоянии

5* 5.1

Pk(j) — вероятность того, что после j этапов исходная

система S находится в состоянии S^ 5.2

— условная вероятность реализации случайного собы-

события sJk при условии sJm 5.2

— матрица переходных вероятностей 5.2

р@) — вектор начальных вероятностей состоянии 5.2

Pk{i) — вероятность реализации случайного события s^., со-

состоящего в том, что в момент времени t G Т система

S находится в состоянии Sfc 5.3

Ajj(i) — плотность вероятности перехода системы из состо-

состояния S, в состояние S3 в момент времени t 5.3

17

p(t) — вектор вероятностей состояний системы в момент

времени t 5.3

Ф{и>) — частотная характеристика линейной динамической

системы 4.4

Г — матрица спектральных интенсивностей белого шу-

шума 7.1

о

?(t,Lo), t&T — центрированный случайный процесс 4.1

t

/ 4l(w(T,uj),T)dw(T,u>) — стохастический интеграл Ито функ-

s ции Ф по винеровскому процессу w(t,uj), tET —

t =[0,oo) 7.3

ty(w(T,u),T)d+w(T,ijj) — стохастический интеграл Стратоно-

вича функции Ф по винеровскому процессу w(t,(j),

teT = [0,оо) 7.3

ft(t,X,T,Y) — условная функция плотности вероятностей мар-

марковского процесса ?(t,u), t ? Т 8.1

U, Um, Umn — множества реализаций случайного процесса

Z{t,u>),teT 9.1

&к (w) — оценка вектора неизвестных параметров /3 Е В С KL,

полученная на основе случайной выборки объема К

из генеральной совокупности случайного процесса

?(t,u), teT, зависящего от 0 9.3

f(y\0) — функция плотности вероятностей случайной выбор-

выборки из генеральной совокупности случайного процес-

процесса ?(t,u>), t ET, зависящего от вектора неизвестных

параметров /3 G В с KL 9.1

A(j3) — информационная матрица Фишера 9.4

L(a\U*) — функция правдоподобия, f/* в {U,Um,UMN} 9.6

Ф(а|{/*) - критерии метода наименьших квадратов 9.7

L(a\U*) — функция квазиправдоподобия 9.6

18

Основные обозначения

Буквы латинского алфавита

Начертание

А

В

С

D

Е

F

G

Н

I

J

К

L

М 1

а

Ь

с

d

е

f

g

h

i

j

k

1

n

A a

В b

С с

D d

E e

F f

G 9

H h

I г

J j

К к

L I

M m

Произно-

Произношение

a

бэ

цэ

ДЭ

e

эф

же

аш

и

йот

ка

эль

эм

Начертание

N п

0 о

Р р

Q q

R г

S s

Т t

U u

V v

W w

X х

Y У

Z z

N п

0 о

Р р

Q ч

R г

S s

Т t

U u

V v

W w

X х

У у

Z z

Произно-

Произношение

эн

о

пэ

ку

эр

эс

тэ

У

вэ

дубль-вэ

икс

игрек

зэт

Представлен наиболее употребительный (но не единствен-

единственный) вариант произношения (в частности, вместо „йот" иногда

говорят „жи").

Буквы греческого алфавита

Начер-

Начертание

А

В

Г

Д

Е

Z

Н

G

a

C

7

S

Е

С

V

Произно-

Произношение

альфа

бета

гамма

дельта

эпсилон

дзета

эта

тэта

Начер-

Начертание

I

К

Л

м

N

[I]

0

п

ь

К

А

М

V

Z

0

IT

Произно-

Произношение

йота

каппа

ламбда

ми

ни

кси

омикрон

пи

Начер-

Начертание

Р

?

Т

т

ф

X

ф

п

р

a

т

V

X

Ф

ю

Произно-

Произношение

ро

сигма

тау

ипсилон

фи

хи

пси

омега

Наряду с указанным произношением также говорят „лямб-

„лямбда'

,мю и „ню

ВВЕДЕНИЕ

Содержание выпуска относится к одному из специальных

курсов высшей математики, который является составной ча-

частью теории вероятностей. В процессе развития теории веро-

вероятностей как науки можно условно выделить три этапа, первый

из которых связан с понятием случайного события, второй —

с понятием случайной величины, а третий — с понятием слу-

случайной функции. При этом начало первого этапа относится к

середине XVII в., второго — к середине XIX в., а третьего —

к 20-30 гг. XX в., и начало каждого следующего этапа, в прин-

принципе, не связано с завершением предыдущего.

Теория случайных процессов возникла вследствие практиче-

практической необходимости математического моделирования реальных

процессов различной природы, состояние каждого из которых в

любой фиксированный момент времени представляет собой слу-

случайный вектор соответствующей размерности. Примером слу-

случайного процесса является процесс изменения во времени про-

пространственных координат частицы, совершающей броуновское

движение. Другими примерами случайных процессов являют-

являются: процесс стабилизации полета самолета в реальных условиях,

когда он находится под постоянным воздействием случайных

изменений вектора скорости ветра и других параметров тур-

турбулентной атмосферы; процесс развития неоднородной популя-

популяции с несколькими типами индивидуумов; процессы спроса и

предложения на рынке товаров и т.д.

Фактически теория случайных процессов занимается изуче-

изучением различных семейств случайных величин, эволюционирую-

эволюционирующих во времени. При этом логически корректное определение

основных понятий теории случайных процессов в рамках акси-

аксиоматики теории вероятностей создавало и создает много труд-

трудностей теоретико-множественного характера. Они связаны,

20 Введение

например, с определениями непрерывности, дифференцируемо-

сти, интегрируемости и других свойств случайных процессов.

Именно поэтому в монографиях по теории случайных процес-

процессов значительное место занимает анализ развития теоретико-

множественных конструкций. Они написаны на высоком те-

теоретическом уровне и, как правило, сложны для понимания

специалистов, занимающихся прикладными проблемами в раз-

различных областях человеческой деятельности, решение которых

предполагает широкое использование методов теории случай-

случайных процессов. А так как литература по прикладным аспектам

теории случайных процессов, доступная для понимания ши-

широкому кругу студентов, аспирантов и научных работников,

имеющих математическую подготовку в объеме стандартного

курса высшей математики, весьма немногочисленна, то возни-

возникла необходимость в написании этой книги.

Основной целью написания предлагаемого учебника яви-

явилось систематическое изложение элементов теории случайных

процессов, усвоение которых должно способствовать активно-

активному овладению ее прикладными методами при решении прак-

практических задач. Различный уровень общей математической

подготовки читателей и разнообразие их запросов авторы по-

попытались учесть компоновкой материала по разделам с воз-

возрастающими уровнями сложности. Все основные понятия и

методы иллюстрированы примерами, а в конце каждой главы

приведены контрольные вопросы и упражнения.

Отметим, что учебник не содержит библиографии по тео-

теории случайных процессов и ее приложениям. В списке рекомен-

рекомендуемой литературы указаны лишь те источники, обращение к

которым поможет читателю получить более полные сведения по

отдельным вопросам теории случайных процессов и в смежных

разделах высшей математики.

Содержание первых четырех глав соответствует базовому

курсу теории случайных процессов. Мы предполагаем, что

читатель может оперировать основными понятиями высшей

математики (элементы линейной алгебры, дифференциальное

21

и интегральное исчисление, тригонометрические ряды Фурье

и интеграл Фурье, обыкновенные линейные дифференциальные

уравнения) и теории вероятностей в объеме втузовского курса.

При этом, для удобства читателей и во избежание разночтения

в соответствующих определениях теории случайных процессов,

авторы сочли целесообразным привести основные определения

базового курса теории вероятностей в приложении 1.

В первой главе введены и обсуждаются основные поня-

понятия теории случайных процессов: случайная функция; случай-

случайный процесс; случайная последовательность; сечение случайной

функции; реализация случайной функции; конечномерный за-

закон распределения случайной функции. Обсуждается вопрос

о корректности задания случайного процесса посредством его

конечномерных законов распределения. Дается определение

стохастически эквивалентных случайных процессов, анализи-

анализируются их свойства и возможные приложения. Вводятся по-

понятия математического ожидания, ковариационной матрицы,

ковариационной функции и связанных с ними числовых харак-

характеристик случайного процесса с последующим изучением их

основных свойств.

Во второй главе рассмотрены важнейшие типы случайных

процессов, представляющих особый интерес для приложений

(стационарные, гауссовские, с независимыми приращениями,

винеровские, марковские, пуассоновские). При этом отмеча-

отмечается особое место винеровских процессов как в теоретических,

так и в прикладных исследованиях.

Третья глава посвящена изложению элементов стохастиче-

стохастического анализа (предел, непрерывность, дифференцируемость

и интегрируемость случайных процессов) с использованием по-

понятия сходимости в смысле среднего квадратичного как наибо-

наиболее приемлемого для практических приложений. В теории слу-

случайных процессов используют и другие виды сходимости и, как

следствие, другие виды непрерывности, дифференцируемости

и интегрируемости — эту информацию читатель может найти

в специальной литературе, например в книге А.Д. Вентцеля.

22 Введение

При рассмотрении технических приложений, в частности при

решении задач о реакции линейных динамических систем на

„шумы" входных сигналов, в данной и последующих главах со-

соответствующие стохастические дифференциальные уравнения

следует воспринимать формально, так как их теория изложе-

изложена лишь в седьмой главе. В последнем разделе третьей главы

введены основные понятия эргодических случайных процессов

и изучены их свойства.

В четвертой главе рассмотрены основные положения спек-

спектральной теории стационарных (в широком смысле) случайных

процессов: представимость стационарных случайных процес-

процессов в виде конечных или счетных сумм гармоник с различными

частотами и случайными амплитудами; интегральное предста-

представление стационарного случайного процесса. Следует отметить,

что в данном учебнике изложена лишь принципиальная схема

обоснования возможности интегрального представления стаци-

стационарного случайного процесса, так как строгое доказательство

является достаточно сложным, в чем читатель может убедить-

убедиться сам, ознакомившись, например, с соответствующим разде-

разделом книги А.Д. Вентцеля. В процессе анализа достаточных

условий существования интегрального представления стацио-

стационарного случайного процесса введено понятие спектральной

плотности как изображения экспоненциального интегрального

преобразования Фурье его ковариационной функции. Приве-

Приведены содержательные интерпретации спектральной плотности

и рассмотрены ее основные свойства. Далее дано определение

„белого шума" как стационарного (в широком смысле) случай-

случайного процесса, обладающего постоянной спектральной плотно-

плотностью, изучены его свойства и возможности использования при

решении практических задач. В качестве одного из возможных

приложений спектральной теории рассмотрены задачи, связан-

связанные с преобразованиями стационарных случайных процессов

при их прохождении через линейные динамические системы.

Следующие две главы посвящены изучению теоретических и

прикладных аспектов теории марковских процессов с дискрет-

23

ными множествами состояний. Заметим, что многие реальные

физические системы имеют не более, чем счетное множество

возможных состояний, а их поведение адекватно моделируется

посредством марковских процессов. Поэтому аппарат теории

марковских процессов с дискретными состояниями широко ис-

используется в теории систем, в исследовании операций и других

прикладных дисциплинах.

В пятой главе, после введения основных понятий теории

марковских процессов с дискретными состояниями и их обсу-

обсуждения, основное внимание уделяется обоснованию и анализу

системы уравнений Колмогорова для вероятностей состояний.

Детально изучаются свойства решения задачи Коши для си-

системы уравнений Колмогорова, для чего использовано пред-

представление соответствующей нормированной фундаментальной

системы решений в виде матричной экспоненты, основные све-

сведения о которой читатель может найти в приложении 2. Для

иллюстрации основных положений теории марковских процес-

процессов с дискретными состояниями даны определения процесса

„гибели — размножения" и циклического процесса, проанали-

проанализированы их свойства и предельные (t~? +oo) характеристики.

В шестой главе изложена элементарная теория массового

обслуживания, которая опирается на методы исследования мар-

марковских процессов с дискретными состояниями. Материал этой

главы предназначен для первого знакомства с теорией массо-

массового обслуживания и ее возможными приложениями, а также

для подготовки читателя к освоению специальной литературы

по этому разделу.

Для усвоения материала седьмой и восьмой глав, в которых

содержатся основные положения теории марковских процес-

процессов с непрерывными состояниями и некоторые ее приложения,

читатель должен быть знаком с элементами теории дифферен-

дифференциальных уравнений математической физики, иметь предста-

представление о постановках задач для дифференциальных уравнений

с частными производными параболического типа и методах их

Решения.

24 Введение

В седьмой главе сформулирован основной принцип постро-

построения детерминированной модели состояния динамической си-

системы, обоснована необходимость введения в нее случайных

возмущений. Доказано, что процесс случайных возмущений

является „белым шумом", и выписана стохастическая модель

состояния, представляющая собой задачу Коши для системы

стохастических дифференциальных уравнений. Далее изучены

свойства решения задачи Коши для системы линейных стоха-

стохастических дифференциальных уравнений и доказано, что этим

решением является нормальный марковский процесс, матема-

математическое ожидание и ковариационная матрица которого явля-

являются решениями соответствующих детерминированных задач

Коши. Кроме того, определены условия, при выполнении кото-

которых этот случайный процесс является стационарным или может

считаться стационарным. В этой же главе введены понятия

стохастических интегралов и дифференциалов, рассмотрены их

свойства и возможности применения при изучении нелинейных

стохастических моделей состояния.

В восьмой главе рассмотрены общие свойства марковских

процессов с непрерывными состояниями, обосновано уравне-

уравнение Маркова — Смолуховского — Чепмена — Колмогорова,

на базе которого выведены первое и второе уравнения Кол-

Колмогорова для условных вероятностей. Значительное внимание

уделено анализу возможных постановок задач для уравнений

Колмогорова и методам их решения. Доказано, что любая

стохастическая модель состояния определяет некоторый мар-

марковский процесс и любой марковский процесс удовлетворяет

некоторой стохастической модели состояния. В качестве ил-

иллюстраций рассмотрены: задача об определении вероятности

пребывания значений марковского процесса в заданной обла-

области; задача об определении закона распределения времени пре-

пребывания значений марковского процесса в заданной области;

задача об определении среднего числа выбросов значений мар-

марковского процесса за данный уровень.

25

Последние две главы посвящены задаче оценивания неиз-

неизвестных параметров случайного процесса по дискретным зна-

значениям его выборочных реализаций. Эта задача занимает

особое место в статистике случайных процессов в связи с ее

прикладной значимостью. Мы предполагаем, что читатель мо-

может оперировать основными понятиями математической ста-

статистики в объеме базового курса.

В девятой главе, после анализа различных возможных ва-

вариантов наблюдений и статистических моментов случайного

процесса, сформулированы задача оценивания его неизвестных

параметров и требования, предъявляемые к ее решению. Для

изучения свойств оценок и методов их определения рассмотре-

рассмотрены случайные выборки, соответствующие различным возмож-

возможным вариантам данных наблюдений, и их совместные функции

плотности вероятностей. Дано определение эффективной оцен-

оценки вектора неизвестных параметров случайного процесса и

проведен анализ неравенства Рао — Крамера. Сформулирова-

Сформулирована и доказана теорема о единственности решения задачи оце-

оценивания. Рассмотрены методы максимального правдоподобия

и наименьших квадратов для нахождения оценок неизвестных

параметров случайного процесса по данным наблюдений и про-

проанализированы их свойства.

Результаты, полученные в девятой главе, использованы в

следующей десятой главе для решения задачи оценивания не-

неизвестных параметров стохастической модели состояния по

данным наблюдений. Установлены условия единственности ре-

решения этой задачи и рассмотрен случай, когда данные наблюде-

наблюдений содержат случайную ошибку измерений. Последнее сделало

уместным рассмотрение основ теории фильтрации, а именно,

фильтра Калмана.

1. ИСХОДНЫЕ ПОНЯТИЯ

И ОПРЕДЕЛЕНИЯ

Теория случайных функций является разделом теории веро-

вероятностей и, как следствие, относится к классической математи-

математике, которая строится дедуктивно, исходя из некоторой системы

аксиом. Основой теории случайных функций являются фун-

фундаментальные понятия и результаты базовых разделов теории

вероятностей.

1.1. Случайная функция, случайный

процесс и случайная последовательность

Пусть (?1,А, Р) — вероятностное пространство; (Кп,В) —

измеримое пространство; t — параметр, совокупность значе-

значений которого Т в общем случае является произвольным множе-

множеством; и G fi — элементарное событие.

Определение 1.1. Случайной функцией f (t,w), t e T,

называют измеримое отображение ?: Q —>¦ Е" пространства

элементарных событий Q в Rn, зависящее от параметра t.

Если Т = [а, 6] — отрезок числовой оси, а параметр t ин-

интерпретируют как время, то вместо термина „случайная функ-

функция" используют термин „случайный процесс". При п= 1

случайный процесс f (?,w), t Е Т, называют скалярным слу-

случайным процессом, а при п J> 2 его называют векторным

случайным процессом или п-мерным случайным процес-

процессом. Векторный (n-мерный) случайный процесс ?(i,o>), t ? Т,

Т

можно записать в виде ?(t,Li>) = (?i(t,uj) ... ^n(^^)) • При этом

скалярные случайные процессы ?t(t,u)), t E.T, называют его ко-

координатными случайными процессами.

1.1. Случайная функция, процесс и последовательность

27

Если T — N, то вместо случайной функции ?(t,u), t ? Т,

говорят о случайной последовательности, которую обо-

обозначают также {^(^)}ь=1-

При любом фиксированном значении параметра t ? Т слу-

случайная функция ?(t,w), t ? Т, является случайным вектором,

называемым сечением этого случайного процесса.

Если зафиксировать элементарное событие ш ? Q, то в этом

случае ?(t,u) является (неслучайной) функцией параметра t,

которую называют траекторией случайного процесса

?(t,u), t ? Т, или его реализацией.

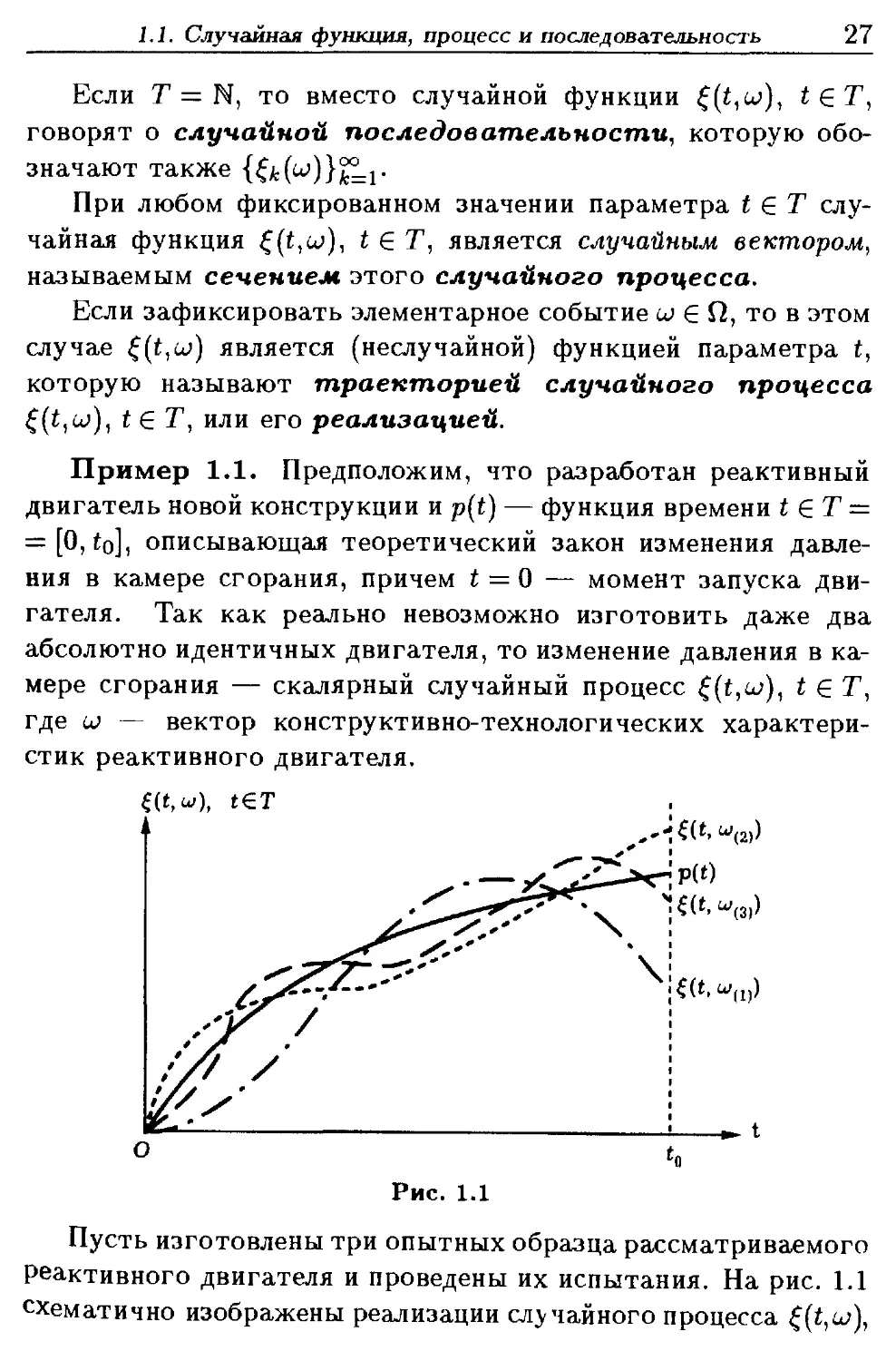

Пример 1.1. Предположим, что разработан реактивный

двигатель новой конструкции и p{t) — функция времени t ? Т —

= [0, to], описывающая теоретический закон изменения давле-

давления в камере сгорания, причем t = 0 — момент запуска дви-

двигателя. Так как реально невозможно изготовить даже два

абсолютно идентичных двигателя, то изменение давления в ка-

камере сгорания — скалярный случайный процесс ^(t,o>), t ? Т,

где и — вектор конструктивно-технологических характери-

характеристик реактивного двигателя.

t€T

(«)

Рис. 1.1

Пусть изготовлены три опытных образца рассматриваемого

реактивного двигателя и проведены их испытания. На рис. 1.1

схематично изображены реализации случайного процесса ?(t,u>),

28 I. ИСХОДНЫЕ ПОНЯТИЯ И ОПРЕДЕЛЕНИЯ

t ЕТ = [0, to]- При этом W(fc) — вектор конструктивно-техно-

конструктивно-технологических характеристик А:-го образца; ?(?,W(fc)) — изменение

давления в камере сгорания Аг-го образца реактивного двигате-

двигателя; t0 — момент окончания фиксации давления. #

Если для случайного процесса ?(t,u>), t ? Т, зафиксировать

произвольное значение параметра t, то получим n-мерный слу-

случайный вектор ?(?,о>), являющийся сечением случайного про-

процесса. Закон распределения вероятностей этого случайного

вектора называют одномерным законом распределения

случайного процесса ?(t,u), t ? Т. Функцию распределения

(вероятностей) случайного вектора ?(t,uj)

X

Ft(x\t)±P[t(t,u,)<x]= J f((y\t)dy,

— оо

где

X Х\ Хп

Jft(y\t)dy = J...Jft(yi,...,yn\t)dyi...dyn,

— оо —оо

называют одномерной функцией распределения случай-

случайного процесса ?(t,tj), t gT, a f((x\t) — одномерной функ-

функцией плотности вероятностей случайного процесса

?(t,u)y t Е Т, которая может быть и обобщенной (см. П1).

Если зафиксировать значения t^ параметра t E T, k — 1, п, то

приходим к совокупности из N случайных n-мерных векторов

^)}^-1 с функцией распределения (вероятностей)

F({x{1),...,x{N)\tu...,tN)±P[{{tk,U) < x(k), k=TJ?} =

= ] ¦¦¦] fdy(i),--4y(N)\h,---,tN)dy{1)...dy{N),

— оо —оо

1.1. Случайная функция, процесс и последовательность 29

называемой конечномерной (N-мерной) функцией рас-

распределения случайного процесса (j{t,Li>), t ? Т. В этом слу-

случае Д(?(!),...,Z(jv)|*i)- -.,?n) — конечнолсернал (JV-лсернал)

функция плотности вероятностей случайного про-

процесса ?(t,u>), t ? Т, (возможно обобщенная). Функции

задают конечномерный (N-мерный) закон распределения

случайного процесса ?(t,a>), t ?Т.

Не следует путать конечномерные функции плотности веро-

вероятностей (функции распределения) случайного процесса и ко-

конечномерные функции плотности вероятностей (функции рас-

распределения) его сечений. В зависимости от контекста мо-

может идти речь об /V-мерной функции плотности вероятностей

(функции распределения) скалярного случайного процесса и об

одномерной функции плотности вероятностей (функции рас-

распределения) векторного случайного процесса.

Фактически случайный процесс ?(?,w), t ? Т, можно рассма-

рассматривать как совокупность всех его возможных сечений. Таким

образом, в общем случае случайный процесс ?(t,u), t ? Т, не

может быть полностью определенным, так как он представим

несчетной совокупностью своих сечений и невозможно постро-

построить совместный закон распределения всех его сечений. Поэтому

любой случайный процесс ?(t,uj), t ? Т = [а, Ь], в общем случае

не является полностью определенным и при решении различ-

различных задач, как теоретического, так и прикладного характера,

исследователь вынужден ограничиваться использованием ко-

конечномерных законов распределений.

Определение 1.2. Случайные процессы f (t,w), t ? Т, и

^(^w), t ? Т, определенные на одном и том же множестве Т, в

одном и том же вероятностном пространстве (Q,A,P) и прини-

принимающие значения в одном и том же измеримом пространстве

(К71,/?), называют стохастически эквивалентными, если

Р [?{t,u) ф r](t,u)] = 0 для любого t ? Т.

30 1. ИСХОДНЫЕ ПОНЯТИЯ И ОПРЕДЕЛЕНИЯ

Таким образом, стохастически эквивалентные случайные про-

процессы ?(t,u)), t Е.Т, и ri(t,uj), t GT, могут отличаться друг от

друга лишь на подмножестве Qq множества Q, имеющем нуле-

нулевую вероятность.

Если случайные процессы ?(?,w), t Е Т, и r}{t,u)), t ? Т,

являются стохастически эквивалентными, то их конечномерные

функции распределения совпадают, т.е.

для любого N ^ 1 и для любых tk € Т, к = 1, N.

Реализации стохастически эквивалентных случайных про-

процессов могут быть совершенно различными.

Пример 1.2. Пусть Т = [0,1] и случайная величина г(ш)

распределена равномерно на множестве Т. Рассмотрим два

случайных процесса:

[о, гфт{ы),

Эти скалярные случайные процессы являются стохастиче-

стохастически эквивалентными. Действительно, при любом t E T имеем

P[S(t,u>)fr(t,u,)] = P[t=T(u)] =0,

n(t, ш), t€T так как в случае непрерывной ска-

скалярной случайной величины веро-

вероятность попадания в точку равна

нулю. Любая реализация случай-

случайного процесса ?(i,w), t е Т, — то-

тождественный нуль, а реализация

случайного процесса ri(t,Lj), t 6 Т,

имеет разрыв в случайной точке

Рис. 1.2 t = r{u)) (рис. 1.2). #

При решении различных задач теоретического и прикладно-

прикладного характера в ряде случаев бывает удобной замена исходного

1 2. Математическое ожидание и ковариационная функция 31

случайного процесса стохастически эквивалентным. Тогда по-

получаемые выводы с точностью до случайных событий, облада-

обладающих нулевой вероятностью реализации, могут быть отнесены

к исходной задаче.

1.2. Математическое ожидание

и ковариационная функция случайного процесса

Совокупность всех конечномерных законов распределения

случайного процесса является полной его характеристикой. Но

при решении многих прикладных задач по разным причинам

ограничиваются использованием одно- и двумерных законов

распределений случайных процессов и связанных с ними мо-

моментов первого и второго порядков, существование которых

предполагается. Отметим, что моментами k-го порядка

случайного процесса называют соответствующие моменты

его сечений.

Определение 1.3. Математическим ожиданием век-

векторного случайного процесса ^(t,uj), t g X1, называют неслу-

неслучайную вектор-функцию m^(t), значение которой при каждом

фиксированном t g T равно математическому ожиданию слу-

случайного вектора ?(t,u>), являющегося сечением исходного слу-

случайного процесса, соответствующего рассматриваемому значе-

значению t.

Если f^(x\t) — одномерная функция плотности вероятно-

вероятностей n-мерного случайного процесса ?(t,u>), t g X1, т.е. плот-

плотность распределения (вероятностей) его сечения (возможно

обобщенная), соответствующего рассматриваемому значению

t G X1, то, согласно определению П1.13 математического ожида-

ожидания случайного вектора, имеем

me (t) =

= J xft(x\t)dx,

32

1 ИСХОДНЫЕ ПОНЯТИЯ И ОПРЕДЕЛЕНИЯ

где f{(x\t) = f((xi,.. ,xn\t), dx-dxidx2...dxr

и для любого фиксированного к = 1, п имеем

где f?k(x).\t) — плотность распределения (вероятностей) к-й

компоненты сечения исходного случайного процесса в момент

времени t ? Т. Таким образом

mk{t)= / xkft(x\t)dx =

К"

— oo \R"-1

и окончательно

teT.

Математическое ожидание m^(t) случайного процесса ?(t,u),

t G Т, можно интерпретировать как его усредненную траекто-

траекторию.

Если / : X —> Y, где X — некоторое множество и У с

С Mmn(R), то при дальнейших рассуждениях будем говорить,

что определена матричная функция типа mXnc областью

определения X и областью значений Y С Mmn{R)

I 2 Математическое ожидание и ковариационная функция 33

Определение 1.4. Ковариационной матрицей (мат-

(матрицей ковариаций) n-мерного случайного процесса ?(t,uj),

t ? Т, называют неслучайную матричную функцию T>t(t) типа

п X п, которая при каждом фиксированном t ? Т представля-

представляет собой ковариационную матрицу случайного вектора ?(?,и),

являющегося сечением исходного случайного процесса, соот-

соответствующего рассматриваемому значению t.

Если f({x\t) — одномерная функция плотности вероятно-

вероятностей в-мерного случайного процесса ?(t,u>), t ? Т, то

= J(x -

x -

где

1

mn(t) J \xn

eMn(R),

и поэтому ковариационная матрица n-мерного случайного про-

процесса f (?,w), t G Т, является симметрической. Ее диагональные

элементы имеют вид

2)] = <rl(t), A = 17^.

Таким образом, при каждом фиксированном i ? Т значение

равно дисперсии скалярной случайной величины, являю-

Щеися k-ii компонентой сечения исходного случайного процесса,

34 1. ИСХОДНЫЕ ПОНЯТИЯ И ОПРЕДЕЛЕНИЯ

соответствующего рассматриваемому значению t. При i ф j по-

получаем, что

т.е. при каждом фиксированном t G Т значение StJ(i), гф j, рав-

равно ковариации двух скалярных случайных величин, являющихся

г-й и j-й компонентами сечения исходного случайного процесса,

соответствующего рассматриваемому значению t.

При решении прикладных задач используют понятие дис-

дисперсии сг?@ n-мерного случайного процесса ?(?,w), t ? Т.

По определению полагают, что

т.е. она равна следу SpS^(t) ковариационной матрицы этого

векторного случайного процесса. При этом очевидно, что

a\{t) = M[{t(t,U) - m^(t))T^(t,u) - т&))].

Определение 1.5. Ковариационной функцией п-мер-

ного случайного процесса ?(?,w), t E T, называют матричную

функцию Kz(ti,t2) типа пхп двух скалярных переменных t\

и ^2) значение которой при фиксированных ti,t2 ё Т равно

ковариации двух случайных векторов ?(t\,u) и

определяемой следующим образом:

=J /

R

(*1(A:) ••• *n(fe)) S Rn И

ная функция плотности вероятностей (возможно обобщенная)

исходного случайного процесса.

1.2. Математическое ожидание и ковариационная функция 35

Согласно определению 1.5, на пересечении г-й строки и j-ro

столбца ковариационной функции K^(ti,t2) га-мерного случай-

случайного процесса ?(t,w), t ?T, находится скалярная функция

KUj{tut2) = M[tf,(tbw) - m,(ti))(f,(t2,w) - m}{t2))]

двух скалярных переменных t\ и t2. Ее значение при фиксиро-

фиксированных t\, ti G Т равно ковариации двух скалярных случайных

величин ?,(t\,u) и ?j(?2)^)j обладающих математическими ожи-

ожиданиями mt(ti), m^t-i) и являющихся г-й и j-й компонентами

и-мерных случайных векторов ?(t\,uj) и ?{t2,u>) соответствен-

соответственно, т.е.

Пример 1.3. Пусть а(и) и /3(и) — скалярные случай-

случайные величины с числовыми характеристиками: М[а(ш)] = та;

ЪЛ[/3{ы)] = тр- D[o(w)] = а2а; D[/3(w)] = <r|; cav[a{u)tfi(u)] = x.

Определим математическое ожидание и ковариационную функ-

функцию скалярного случайного процесса

?(t,w) = а{ш)cos{(pt) + C{uj)s\n{ipt), t e T = [0, ос),

где <р ? R — постоянная. Имеем

= macos(ipt)

Пусть далее

Тогда

0 о °

= a(u)cos(<pt)+f3{u)sln(<pt).

36 1 ИСХОДНЫЕ ПОНЯТИЯ И ОПРЕДЕЛЕНИЯ

В этом случае

[i(t,,w)i(t2,w)] = M[(aHJ]cosM

cos((pt2)}

s\n(<pt2) = <TaCas(<pt

+t2)] + (Tps\n(<ptx) sin (<pt2).

В частности, если случайные величины a(a>), /3(a>) являются

некоррелированными {х— 0) и сг^ = сг2 = сг^, то

Теорема 1.1. Пусть ?(i,a>), t ?Т, — n-мерный случайный

процесс, для которого существует ковариационная функция

Kz(ti,t2). Тогда

3) евклидова норма ковариационной функции, т.е. корень

квадратный из суммы квадратов ее элементов, удовлетворяет

неравенству Коши — Буняковского

4) если (p(t) — неслучайная n-мерная вектор-функция ска-

скалярного аргумента t 6 Т, A{i) — матричная неслучайная функ-

функция типа п X п, определенная на Т, и

teT,

то в этом случае

5) если ковариационная функция K^(ti,t2) непрерывна в

точках диагонали tx = t2 квадрата Т х Т, то она непрерывна

в любой другой точке этого квадрата;

1 2 Математическое ожидание и ковариационная функция 37

6) для любого тI и для любого множества {^IJiLj S Т

точек отсчета квадратичная форма

nm переменных z,k, г = 1, n, к = 1, m, является неотрицательно

определенной.

•4 Первое утверждение следует непосредственно из определения

ковариационной функции и свойств операции транспонирова-

транспонирования матриц, так как

Второе утверждение следует непосредственно из определе-

определения 1.4 ковариационной матрицы и определения 1.5 ковариаци-

ковариационной функции случайного процесса, так как

Третье утверждение следует из неравенства Шварца для

математического ожидания

в котором

a(w) = (o!H ... on(w))T,

если считать, что

Для доказательства неравенства Шварца предположим, что

А € К — неслучайный параметр. Тогда для любого А

О <С М[(а(ш) + \р(и))Т(а{и) + Щи))] =

38 1. ИСХОДНЫЕ ПОНЯТИЯ И ОПРЕДЕЛЕНИЯ

и поэтому дискриминант этого квадратного трехчлена неотри-

неотрицателен. Это дает неравенство

В случае скалярных случайных величин а(ш) — Q:;(u)), /3(ш) =

= /3j(w) это неравенство превращается для них в неравенство

Шварца

Используя его в векторном случае, получаем

i=\ j=\ i=\

что и завершает доказательство неравенства Шварца.

Чтобы доказать четвертое утверждение, достаточно вос-

воспользоваться очевидными равенствами:

J7(t,w) - mv{t) = A{t){t{t,u>) - me(t)), t e T,

и определением 1.5 ковариационной функции. Действительно,

Для доказательства пятого утверждения положим

1.2. Математическое ожидание и ковариационная функция 39

и рассмотрим

+

где использованы неравенство треугольника [IV] и неравенство

Шварца. А так как

Л,« + Л) - ff{(M + Л) - ||

и по условию

lim Kf{t + h,t + h)= lim AV(t + h,t) = lim ^(t,t + Л) = Kt(t,t)

Л+0 v /i>0 V ' /i>0 V tV '

Для любого t € Г, то утверждение 5 доказано полностью.

Для доказательства шестого утверждения теоремы 1.1 рас-

рассмотрим выражение

40 1. ИСХОДНЫЕ ПОНЯТИЯ И ОПРЕДЕЛЕНИЯ

А так как в левой части записано математическое ожидание

неотрицательной случайной величины, то оно неотрицательно,

и утверждение 6 доказано. >

Замечание 1.1. По аналогии с коэффициентом корреля-

корреляции двух скалярных случайных величин в теории случайных

процессов используют понятие корреляционной функции

Замечание 1.2. Если случайный процесс ?(t,u), t e T,

принимает значение в измеримом пространстве X С С, то его

называют комплексным случайным процессом. Для него

где символ ,,*" означает операцию комплексного сопряжения.

Таким образом, если ?(i,tj), t ? Т, — комплексный случайный

процесс, то

где f(t,w) A ^(t,uj) + tft(«,w), * G T, a €i(t,w), t G T, и

t ?T, — скалярные случайные процессы.

Пример 1.4. Пусть A(uj) = o(u) + ib(u) — комплексная

случайная величина с нулевым математическим ожиданием,

(р ? К — неслучайный скалярный параметр и комплексный

случайный процесс ?(i,w), t ?T, имеет вид

b(u)s\n(<pt)) +

+ i F(w) cos(y>i) + o(w) sin(^)), t G Г = [0, oo).

1.2. Математическое ожидание и ковариационная функция 41

Тогда

(uf)etvt] = M[A(u)]etvt = G;

= M[A*(uj)A(u)]exp[iip(t2 -h)] =

= M[a2{u) + 62(cj)]cos(v>(t2 -ti)) +

+ iM[a2(w) + b2{u)]sm(<p[t2 -

Определение 1.6. Взаимной ковариационной функ-

функцией двух n-мерных случайных процессов ?(t,u), t ? Т, и

r)(t,u>), t ? Т, определенных на одном и том же множестве

TcR и на одном и том же вероятностном пространстве

(Q,A,P), принимающих значения в одном и том же измери-

измеримом пространстве X с Кп, называют неслучайную матричную

функцию K^v(ti,t2) типа пхп двух скалярных аргументов t\

и t2, значение которой при фиксированных t\tt2 S Т равно ко-

вариации случайных векторов f(?i,w) и r](t2,u), определяемой

следующим образом:

Ktn{h,t2) —

Г Г

;-mc(ti)) (y-mv(t2)) f(n{x,y\tut2)dxdy,

где ftr){x,y\ti,t2) — функция плотности вероятностей Bп)-

Мерного случайного вектора (^ (ti,u) T}T(t2,uj)) .

Согласно определению 1.6, на пересечении г'-й строки и j-ro

столбца взаимной ковариационной функции /^(ti,^) находит-

находится скалярная функция

42 I. ИСХОДНЫЕ ПОНЯТИЯ И ОПРЕДЕЛЕНИЯ

Взаимная ковариационная функция обладает следующими

свойствами:

a) ^

в) если (pi(t), <fi2{t) — неслучайные n-мерные вектор-функ-

вектор-функции, A\(t), Лг@ — неслучайные матричные функции типа

п X п, определенные наТсК, и при к = 1,2

* б Г,

где ^(i)(t,w) и fB)(?,w) — n-мерные случайные процессы, опре-

определенные на одном и том же множестве TcR, одном и том

же вероятностном пространстве (Q,A,P) и принимающие зна-

значения в одном и том же измеримом пространстве X С Кп, то

Вопросы и задачи

1.1. Почему любое сечение n-мерного векторного случайно-

случайного процесса является n-мерным случайным вектором?

1.2. Существует ли связь между /V-мерным и (N — ^-мер-

^-мерным законами распределения случайного процесса, где N ^ 2?

Если эта связь существует, то укажите ее с использованием:

а) функций распределения; б) функций плотности вероятно-

вероятностей.

1.3. Возможно ли в общем случае адекватное описание слу-

случайного процесса с помощью конечномерных законов распреде-

распределения?

1.4. Можно ли определить математическое ожидание слу-

случайного процесса, если известна его: а) одномерная функция

распределения; б) двумерная функция плотности вероятностей?

1.5. Как связаны между собой дисперсия и ковариационная

матрица случайного процесса?

Вопросы и задачи 43

1.6. В чем заключается принципиальное отличие ковариа-

ковариационной функции случайного процесса от его ковариационной

матрицы?

1.7. Можно ли ввести корреляционную функцию для скаляр-

скалярного случайного процесса? В случае положительного ответа,

сформулируйте ее основные свойства.

1.8. Постройте семейство реализаций (траекторий) скаляр-

скалярного случайного процесса

где и(ш) — скалярная случайная величина, распределенная по

закону Пуассона с параметром ц = 0,5.

Ответ: A + t2)~ln; n = 0, 1, 2,...

1.9. Докажите, что конечномерные распределения стохасти-

стохастически эквивалентных случайных процессов совпадают.

1.10. Являются ли стохастически эквивалентными скаляр-

скалярные случайные процессы ?(t,u), t ?Т, и ri(t,u>), t ? Т, если

Г = [а,Ь]и:

а) ф,ы) 4 ${t,u){J(t - a) - J[t - (a + 6)/2]};

б) r}(t,u)=?(t,u){l-S[t-(a + b)/2]}, где J(t) — единичная

функция, a S(t) — ^-функция Дирака.

Ответ: а) нет; б) да.

1.11. Пусть а(и) и /3(tj) — неотрицательные скалярные

случайные величины с известным совместным законом распре-

распределения, а скалярная случайная величина j{u>) не зависит от

них и равномерно распределена на отрезке [0, 2тг]. Докажите,

Что любое конечномерное распределение скалярного случайно-

случайного процесса

(u>)t + 7(w)], t G T С R,

не зависит от сдвига по времени, т.е. для любых N ^ 1, ?* € Г,

к= 1, N, и h € R, такого, что f* -f h e T, к ?= 1, iV, имеет место

44 1. ИСХОДНЫЕ ПОНЯТИЯ И ОПРЕДЕЛЕНИЯ

тождество

1.12. Для случайного процесса из задачи 1.8 определите

математическое ожидание и дисперсию.

Ответ: m{(t) = 1/2A -И2); a*(t) = 1/2A -И2J-

1.13. Определите математическое ожидание, дисперсию и

ковариационную функцию скалярного случайного процесса

?(i, w) = 2tt(w)ein(irt) + 3u(u)i2 + 5, t e Г,

где v — известный неслучайный параметр, а и(и) и u(w) — ска-

скалярные случайные величины с известными числовыми характе-

характеристиками: М[и(и>)] = 1; M[v(u)] = 2; D[u(u)] - 0,1; D[u(w)] =

= 0(9;/)(ti(w);»(w)) = -0,3.

Ответ:

m^(i) = 2sin(i^) + 6t2 + 5;

aj(t) = 0,4sin2(i/f) +8,It4 - l,08?2sin(i/f);

t2) =0,4sin(i/ti)sin(i/t2) |

1.14. Пусть известны числовые характеристики двумерного

случайного вектора и(и) = (ui(lj)

Найдите математическое ожидание, дисперсию и ковариацион-

ковариационную функцию скалярного случайного процесса

?(?,ш) = ui(uj)cost + U2(ti>)smt + t, t eT.

Ответ:

^{t) = -0,5 cost + siat +1;

2 2 2,9sin2t-2sin2f;

- 2sin(ii

Вопросы и задачи 45

1.15. Найдите математическое ожидание, ковариационную

функцию, дисперсию и одномерный закон распределения ска-

скалярного случайного процесса

где а(ш) и j3(u;) — независимые скалярные случайные величины,

распределенные по нормальному закону с нулевым математиче-

математическим ожиданием и дисперсией о1 — 0,25.

Ответ:

f2) = 0,25^2

o\{t) = 0,25?2(l+?2); Д(яг|*) =

1.16. Найдите ковариационную функцию и дисперсию ска-

скалярного случайного процесса

fc(w)ras(i/*t) +/3*Hsm(i/Af)], (eTcE,

если i/к, /с = 1,п, — известные неслучайные параметры, не-

некоррелированные скалярные случайные величины <*/ь(и;), /3k(u),

/с=1,п, имеют нулевые математические ожидания и равные

дисперсии D[aifc(a>)] = D[/3fc(a>)] = о\,к = Т~п.

Ответ:

KdhM) = f^clco&kih - t,)]; o\(t) =

1.17. Найдите взаимную ковариационную функцию скаляр-

скалярных случайных процессов

?{t,u) = а(ш) sin(i/t) + /3(и) cos(ut), t e Г С R,

77(t,o>) = a(w)sin(i/t) +7(w)cos(i/t), t ? T с R,

46 1. ИСХОДНЫЕ ПОНЯТИЯ И ОПРЕДЕЛЕНИЯ

если v — известный неслучайный параметр, а скалярные слу-

случайные величины л(и»), /3(ш), т(и>) являются попарно некорре-

некоррелированными.

Ответ: K^fafy) = sin(i/?i)sin(i/?2)D[a(u>)].

1.18. Пусть ?i(t,w), t € Т, и ?2(t,^), teT, — два скаляр-

скалярных случайных процесса, для которых известны ковариацион-

ковариационные функции K^(ti,t2), KB(t\,t2) и взаимная ковариационная

функция K^2(ti,t2). Найдите ковариационную функцию ком-

комплексного случайного процесса

если a(i), 6(i), c(t), d(t) — известные неслучайные функции,

определенные при t ? Т.

Ответ:

2. НЕКОТОРЫЕ ТИПЫ

СЛУЧАЙНЫХ ПРОЦЕССОВ

Для построения конструктивной теории, позволяющей ре-

решать различные задачи как теоретического, так и прикладного

характера, необходимо конкретизировать общее определение

случайного процесса (см. 1). Рассмотрим важнейшие типы слу-

случайных процессов, представляющих особый интерес для прило-

приложений.

2.1. Стационарные случайные процессы

Определение 2.1. Случайный процесс €(t,u), t G T = [а, 6],

называют стационарным в узком смысле, если для любых

N^l,tk?T, k = T77V, и h € К, такого, что tk + h ? Т, k = 1,7V,

имеет место тождество

или, что то же самое,

, • • • ,tN) = /e(z(i),... ,Z(N)Ni + h,...,tN + h).

Если стационарный в узком смысле случайный процесс

?(t,tj), t?T — [a,b], имеет моменты первого и второго по-

порядков, то его математическое ожидание M[?(t,tj)] = m^ —

постоянный вектор, а ковариационная функция зависит лишь

от разности аргументов, т.е.

Действительно, полагая h = a — t, получаем

*,ш)]= I xfi{x\t)dx= I xfi(x\a)dx =

R" Rn

48 2. НЕКОТОРЫЕ ТИПЫ СЛУЧАЙНЫХ ПРОЦЕССОВ

Совершенно аналогично, полагая h = a — t\, приходим ко второ-

второму тождеству:

= / I

R"R"

/ (x(i

R"R"

Определение 2.2. Случайный процесс ?(t,u>), t ?T, назы-

называют стационарным в "широком смысле, если его матема-

математическое ожидание — постоянный вектор, а ковариационная

функция зависит от разности аргументов, т.е.

Mfc(t.w)] = mi = const, K((tut2) = Kt{t2 - tj).

Таким образом, из стационарности в узком смысле следует

стационарность в широком смысле.

В той мере, в какой теория случайных процессов отражает

явления реального мира, понятие стационарности случайного

процесса отражает идею неизменности (стационарности) усло-

условий, в которых он протекает.

Заметим, что случайный процесс, рассмотренный в примере

1.3, является стационарным в широком смысле, если случайные

величины a(u>), /3(w) являются некоррелированными, имеют

нулевые математические ожидания и одинаковые дисперсии.

Пример 2.1. Пусть скалярные случайные величины а(о>),

/3(w), у(ш) обладают следующими свойствами:

а) a(w) и /3(и>) положительный /«/3B:1,2:2) — плотность рас-

распределения (вероятностей) случайного вектора (<*(uj) /3(w)) ;

б) у(ш) не зависит от а(ш) и /3(w) и распределена по равно-

равномерному закону на отрезке [0, тг].

2.1. Стационарные случайные процессы

49

Докажем, что случайный процесс

, teT=[a,b],

является стационарным в узком смысле, начав с определения

его одномерного закона распределения.

Фиксируем значение t ? Т. В этом случае сечением рассма-

рассматриваемого случайного процесса является случайная величина

представляющая собой функцию случайных величин a(w), /3(ш),

7(w). Функция плотности вероятностей случайного вектора

(а(и>) /3(ш) у(ш)) имеет вид

/а/З-у {Х\ , Х2, Х3) = fa

(Х3).

Из равенства

следует, что

О,

Поэтому, согласно теории построения законов распределения

функций случайных величин, находим [XVI]

оо оо

где

,-1

50 2. НЕКОТОРЫЕ ТИПЫ СЛУЧАЙНЫХ ПРОЦЕССОВ

и не зависит от значения t. Кроме того, по условию случайная

величина у(и>) распределена равномерно на отрезке [0,7г], т.е.

функция плотности вероятностей /«у инвариантна относительно

сдвига аргумента. Таким образом,

Для N > 1 нужно определить закон распределения N-мерно-

го случайного вектора с компонентами

и доказать, что

Л (У1, - - •, УЛГ | *i, • • -,*лг) = Л (yi, - ¦ ¦, !/jv | «1 + Л,..., *tv + Л).

Далее принципиальная схема рассуждений аналогична ис-

использованной в одномерном случае и потому не приводится.

2.2. Нормальные процессы

Определение 2.3. Случайный процесс ?(t,w), t G T =

= [a, b], называют нормальным, или гауссовым процессом,

если любые его конечномерные законы распределения являются

нормальными.

Пусть ?(t,uj), t ЕГ, — n-мерный нормальный процесс с ма-

математическим ожиданием m^(t) и ковариационной функцией

К{A,т). В этом случае для любого JV^l и для любых ?& G Т

известны значения его математического ожидания

W)]) k=l,N,

и ковариационной функции

2.2. Нормальные процессы

51

Введем в рассмотрение блочные матрицы-столбцы, которые

при дальнейших рассуждениях будем называть блочными

векторами:

те(и\ \

и блочную матрицу

... K€{tutN)

,t2) ... K^(tfi,tN)

Не останавливаясь на анализе особых случаев, связанных с

возможной линейной зависимостью сечений рассматриваемого

случайного процесса, будем считать, что |V}v| ф 0.

Блочный вектор г}^(ш) является (пЛ^)-мерным случайным

вектором с математическим ожиданием т^ и ковариационной

матрицей V)y. А так как ?(t,w), t GT,

чайный процесс, то случайный вектор

нормальному закону и

нормальный слу-

слу) распределен по

ш =

1

I ехр

Г 2 ^У ~

является iV-мерной функцией плотности вероятностей для

случайного процесса ?(t,uj), t ?T.

Таким образом, любой конечномерный закон распределения

нормального случайного процесса полностью определяется его

математическим ожиданием и ковариационной функцией.

Если ?(t,u>), t G T, — n-мерный стационарный нормаль-

нормальный случайный процесс, то его математическое ожидание —

постоянный п-мерный вектор, а аргументом ковариационной

функции является параметр г = *2 ~h-

52 2. НЕКОТОРЫЕ ТИПЫ СЛУЧАЙНЫХ ПРОЦЕССОВ

В силу центральной предельной теоремы [XVI] нормальные

случайные процессы в ряде случаев оказываются предельными

для сумм возрастающего числа случайных процессов.

2.3. Процессы с независимыми приращениями

Определение 2.4. Случайный процесс?(?,w), t ? Т С R, на-

называют процессом с независимыми приращениями, если

для любых N > 1 и tk ? Т, к — 1, N, таких, что t\ < ti < ... < tyy,

случайные величины

являются мезависильи«и.

В практике научных исследований встречаются случайные

процессы, родственные (в определенном смысле) случайным

процессам с независимыми приращениями. Отметим некото-

некоторые из них.

1. Если n-мерные случайные векторы ^(^,0;), ?(?2,w) -

-f(*bw)i •••, ?(?n,w) - ?(?n-1iw) являются, вообще говоря,

зависимыми, но некоррелированными, то n-мерный случайный

процесс ?(?,w), t G Т, называют процессом с некоррелиро-

некоррелированными (ортогональными) приращениями.

2. Если для любых N > 1 и tk ? Т, к = 1, N, закон распреде-

распределения приращения ?(?fc+1,w) — ?(?/t,w) зависит лишь от t^+i — t^,

k= 1, TV—1, то случайный процесс f(?,w), ? е Т, с независимы-

независимыми приращениями называют процессом со стационарными

независимыми приращениями.

Случайный процесс f (?,u>), t G Т С К, с независимыми при-

приращениями полностью определен одномерным законом распре-

распределения Д(х|?), характеризующим случайный вектор ?(?i,w), и

двумерным законом распределения /{(*(iIa;B)Uii*2), характе-

характеризующим приращения ?(?jt+ilW) — ?(?*,«), &= 1,-W—1.

2.3. Процессы с независимыми приращениями 53

Пример 2.2. Пусть ?(t,u), teTcR, — случайный процесс

с ортогональными приращениями и требуется определить его

ковариационную функцию.

Полагая t2 > ^1, имеем

= cov

cov [

где последние равенства следуют из свойств ковариации и

некоррелированности случайных величин ?(t\,u)) и ?(?2,w) —

Рассуждая аналогично, при t\ > t2 получаем

Таким образом, с учетом связи ковариационной функции слу-

случайного процесса и его ковариационной матрицы, имеем

О*;

s^t. #

Отметим, что процесс с независимыми приращениями явля-

является процессом с ортогональными приращениями. Поэтому

результат, полученный при рассмотрении примера 2.2, имеет

место для любого процесса с независимыми приращениями.

Пример 2.3. Пусть ?(t,u>), teTcR, — процесс с ортого-

ортогональными приращениями. Для t, s ?T, s <t, положим

Так как исходный случайный процесс является процессом с

ортогональными приращениями и s < t, то

-?fe,w)l=0.

54 2 НЕКОТОРЫЕ ТИПЫ СЛУЧАЙНЫХ ПРОЦЕССОВ

Таким образом,

-s) = covR;(*,w) -?(e,w); ?(t,w)] =

т.е. ковариационная матрица приращения ?(?,w) — ^(s,uj) равна

разности ковариационных матриц соответствующих сечений

?(t,u>) и ?(s,u) исходного случайного процесса. #

Если воспользоваться формальным определением функции

— s), приведенным в примере 2.3, то при s < f и s, t>0

Но в этом случае

flc(*-e) = cov

- K(«,w) - ?@,w)); Й(«,w) - f@,w)) - (f(e,w) -

А так как

(e,w); (f (t,w) - ^(e,w)) + (f (e,w) -

то приходим к равенству

2.4. Винеровскнй процесс 55

которое имеет место для любых t,s?T, удовлетворяющих нера-

неравенству s < t. Можно показать, что если R((t) — непрерывная

функция, то

= At.

Кроме того, для процесса с ортогональными приращениями

?(t,uj), t ?T, такого, что

имеют место равенства

Значит, ковариационная функция равна

или

Kz{s,t) = Amin{t;s}.

2.4. Винеровский процесс

Определение 2.5. Если ?(t,w), t?T= [0,со), — п-мерный

случайный процесс, то его называют винеровским процес-

процессом, выходящим из О, если выполнены три условия:

2) для любых N > 1 и tk e T, k = 1, N, таких, что 0 < t\ <

2 < ... <tN, случайные векторы ^(ti,u), ^(t2,uj) -^(ti,u), ...,

,uj) —?(tN-\,uj) являются независимыми;

3) для любых tltt2 е Т, таких, что 0 ^ tx < t2, случайный

вектор ?(?г,^) -?(ti,u>) распределен по нормальному закону с

нулевым математическим ожиданием и ковариационной ма-

матрицей (*2 - t\)a2ln, где /„ € Mn(R) — единичная матрица.

Винеровский процесс, или процесс броуновского движения,

имел большое значение при разработке теории случайных про-

процессов. Многие распределения, используемые в теории упра-

56 2 НЕКОТОРЫЕ ТИПЫ СЛУЧАЙНЫХ ПРОЦЕССОВ

вления, можно моделировать процессами, порождаемыми вине-

ровскими процессами.

В 1827 г. английский ботаник Р. Броун заметил, что

маленькие частицы диаметром около микрона, погруженные

в жидкость, находятся в постоянном хаотическом движении.

В 1905 г. А. Эйнштейн объяснил это движение как результат

столкновения частиц с молекулами жидкости. Он разработал

математическую модель броуновского движения и определил

число Авогадро, равное числу молекул в объеме, занятом молем

газа.

Строгий математический анализ броуновского движения

дал Н. Винер в 1923 г. Эвристически броуновское движение

можно объяснить следующим образом. Рассмотрим отдельную

частицу, погруженную в жидкость, обозначив через ?i(?), ?г@>

?з@ ее координаты в момент времени t > 0. Будем считать, что

в начальный момент времени t = 0 она находится в начале ко-

координат, т.е. &@) = 0, к = 1,2,3. Движение частицы на любом

конечном временном интервале является результатом измене-

изменения импульса (количества движения) вследствие практически

бесконечно большого числа независимых друг от друга соуда-

соударений с молекулами жидкости. Поэтому естественно считать,

что применима центральная предельная теорема [XVI]. Кроме

того, можно допустить, что:

а) смещения частицы в ортогональных направлениях проис-

происходят независимо;

б) ?k{t), к = 1,2,3, распределены по нормальному закону с

нулевым математическим ожиданием и дисперсией <r^(t);

в) смещение частицы в каждом к-ои ортогональном напра-

направлении на различных непересекающихся временных интервалах

0 < t\ < ... < ttf представляется независимыми случайными ве-

величинами €k(h), &(<2)-&(*i), •••> &(fN)-6:(fN-i);

г) смещение частицы в каждом к-ом ортогональном напра-

направлении на временном интервале (t, t + h), равное ?k{t + h) —

имеет ту же функцию распределения, что и смещение

2.4. Винеровский процесс 57

Отметим также, что дисперсия o2{t) = D[?/t(?)] обладает

любопытным свойством:

где постоянную а2 интерпретируют как коэффициент диф-