Автор: Миллер Б.М. Панков А.Р.

Теги: теория вероятностей и математическая статистика теория вероятностей математическая статистика комбинаторный анализ теория графов математика

ISBN: 5-9221-0206-0

Год: 2002

Текст

УДК 519.21

М60

ББК 22.171

Рецензент:

академик РАН Н.А. Кузнецов

Миллер Б. М., Панков А. Р. Теория случайных процес-

процессов в примерах и задачах. - М.: ФИЗМАТЛИТ, 2002. - 320 с. -

ISBN 5-9221-0206-0.

В книге изложены основы современной теории случайных процессов. Опи-

Описаны важнейшие модели процессов с дискретным и непрерывным временем,

методы их исследования и использования для решения прикладных задач.

Рассмотрены решения многочисленных типовых примеров, приведены задачи

для самостоятельного решения.

Для студентов и аспирантов технических университетов, специализирую-

специализирующихся в области прикладной математики, теории управления, обработки

информации и экономики.

ISBN 5-9221-0206-0 © ФИЗМАТЛИТ, 2002

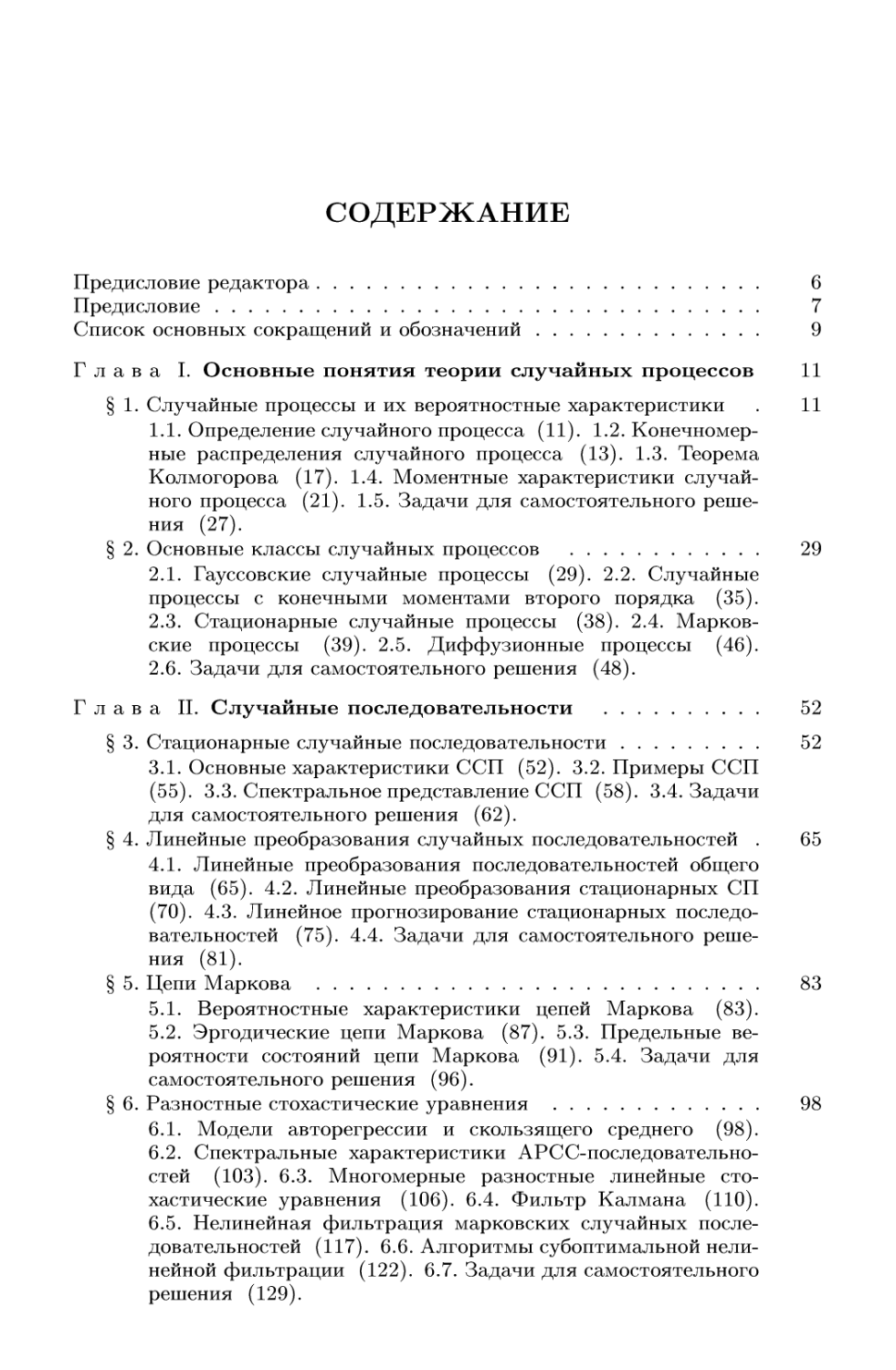

СОДЕРЖАНИЕ

Предисловие редактора 6

Предисловие 7

Список основных сокращений и обозначений 9

Глава I. Основные понятия теории случайных процессов 11

§ 1. Случайные процессы и их вероятностные характеристики . 11

1.1. Определение случайного процесса A1). 1.2. Конечномер-

Конечномерные распределения случайного процесса A3). 1.3. Теорема

Колмогорова A7). 1.4. Моментные характеристики случай-

случайного процесса B1). 1.5. Задачи для самостоятельного реше-

решения B7).

§ 2. Основные классы случайных процессов 29

2.1. Гауссовские случайные процессы B9). 2.2. Случайные

процессы с конечными моментами второго порядка C5).

2.3. Стационарные случайные процессы C8). 2.4. Марков-

Марковские процессы C9). 2.5. Диффузионные процессы D6).

2.6. Задачи для самостоятельного решения D8).

Глава П. Случайные последовательности 52

§ 3. Стационарные случайные последовательности 52

3.1. Основные характеристики ССП E2). 3.2. Примеры ССП

E5). 3.3. Спектральное представление ССП E8). 3.4. Задачи

для самостоятельного решения F2).

§ 4. Линейные преобразования случайных последовательностей . 65

4.1. Линейные преобразования последовательностей общего

вида F5). 4.2. Линейные преобразования стационарных СП

G0). 4.3. Линейное прогнозирование стационарных последо-

последовательностей G5). 4.4. Задачи для самостоятельного реше-

решения (81).

§ 5. Цепи Маркова 83

5.1. Вероятностные характеристики цепей Маркова (83).

5.2. Эргодические цепи Маркова (87). 5.3. Предельные ве-

вероятности состояний цепи Маркова (91). 5.4. Задачи для

самостоятельного решения (96).

§ 6. Разностные стохастические уравнения 98

6.1. Модели авторегрессии и скользящего среднего (98).

6.2. Спектральные характеристики АРСС-последовательно-

стей A03). 6.3. Многомерные разностные линейные сто-

стохастические уравнения A06). 6.4. Фильтр Калмана A10).

6.5. Нелинейная фильтрация марковских случайных после-

последовательностей A17). 6.6. Алгоритмы субоптимальной нели-

нелинейной фильтрации A22). 6.7. Задачи для самостоятельного

решения A29).

СОДЕРЖАНИЕ

§ 7. Мартингалы с дискретным временем 131

7.1. Основные определения A31). 7.2. Марковские моменты.

Случайная замена времени в мартингале A38). 7.3. Теоремы

сходимости мартингалов и их приложения A41). 7.4. Задачи

для самостоятельного решения A45).

Глава III. Случайные функции 147

§ 8. Элементы анализа случайных функций 147

8.1. Непрерывность случайных функций A47). 8.2. Диф-

Дифференцирование случайных функций A53). 8.3. Интегриро-

Интегрирование случайных функций A57). 8.4. Дифференциальные

уравнения со случайной правой частью A61). 8.5. Задачи

для самостоятельного решения A66).

§ 9. Стационарные случайные функции 167

9.1. Основные характеристики стационарных случайных

функций A67). 9.2. Примеры ССФ A70). 9.3. Линейные

преобразования ССФ A75). 9.4. Задачи для самостоятель-

самостоятельного решения A85).

§ 10. Случайные функции с ортогональными и независимыми при-

приращениями 188

10.1. Основные понятия и определения A88). 10.2. Одно-

Однородные процессы с ортогональными приращениями A93).

10.3. Мартингалы (непрерывное время) A96). 10.4. Вине-

ровский процесс B05). 10.5. Задачи для самостоятельного

решения B10).

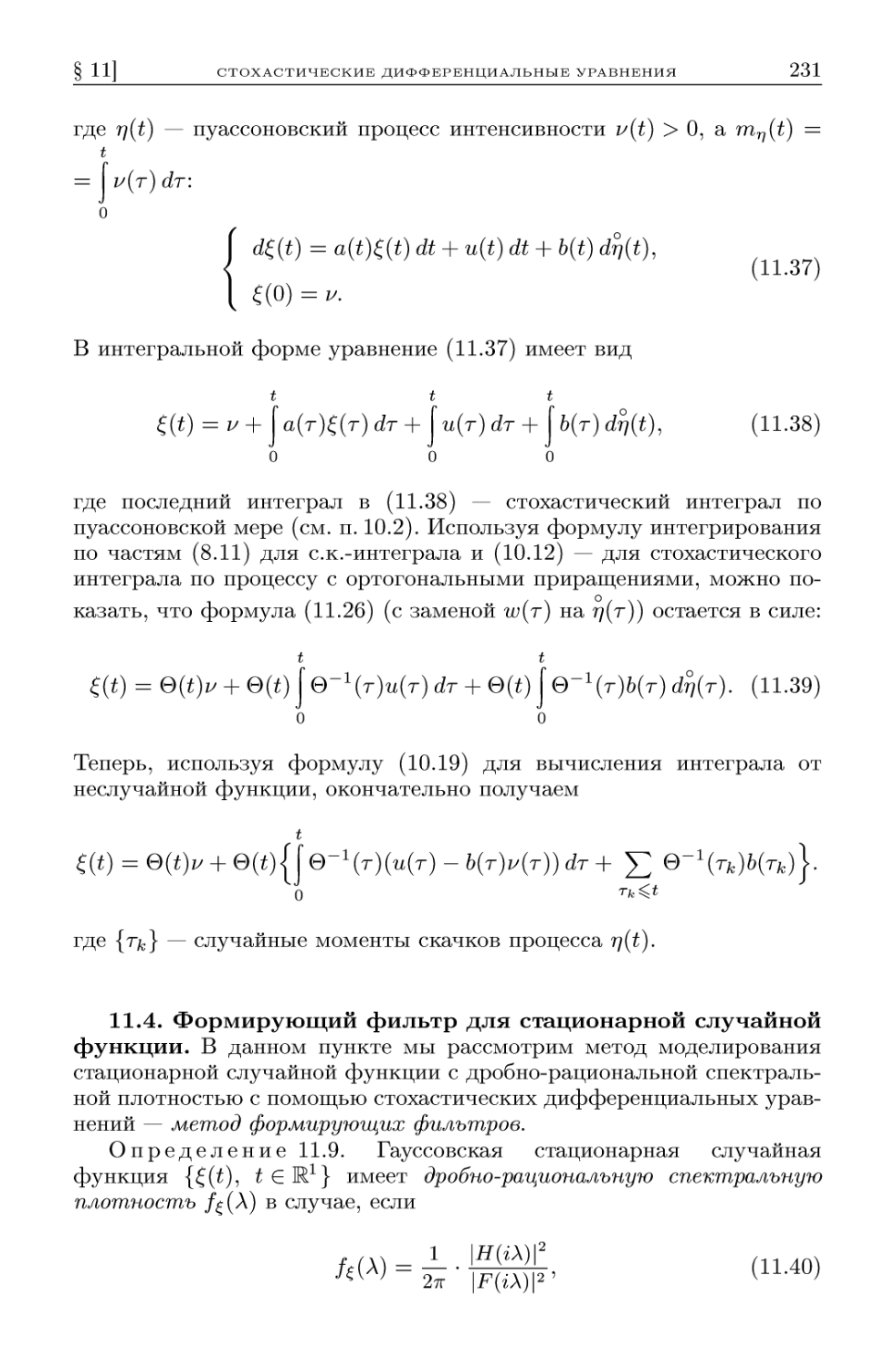

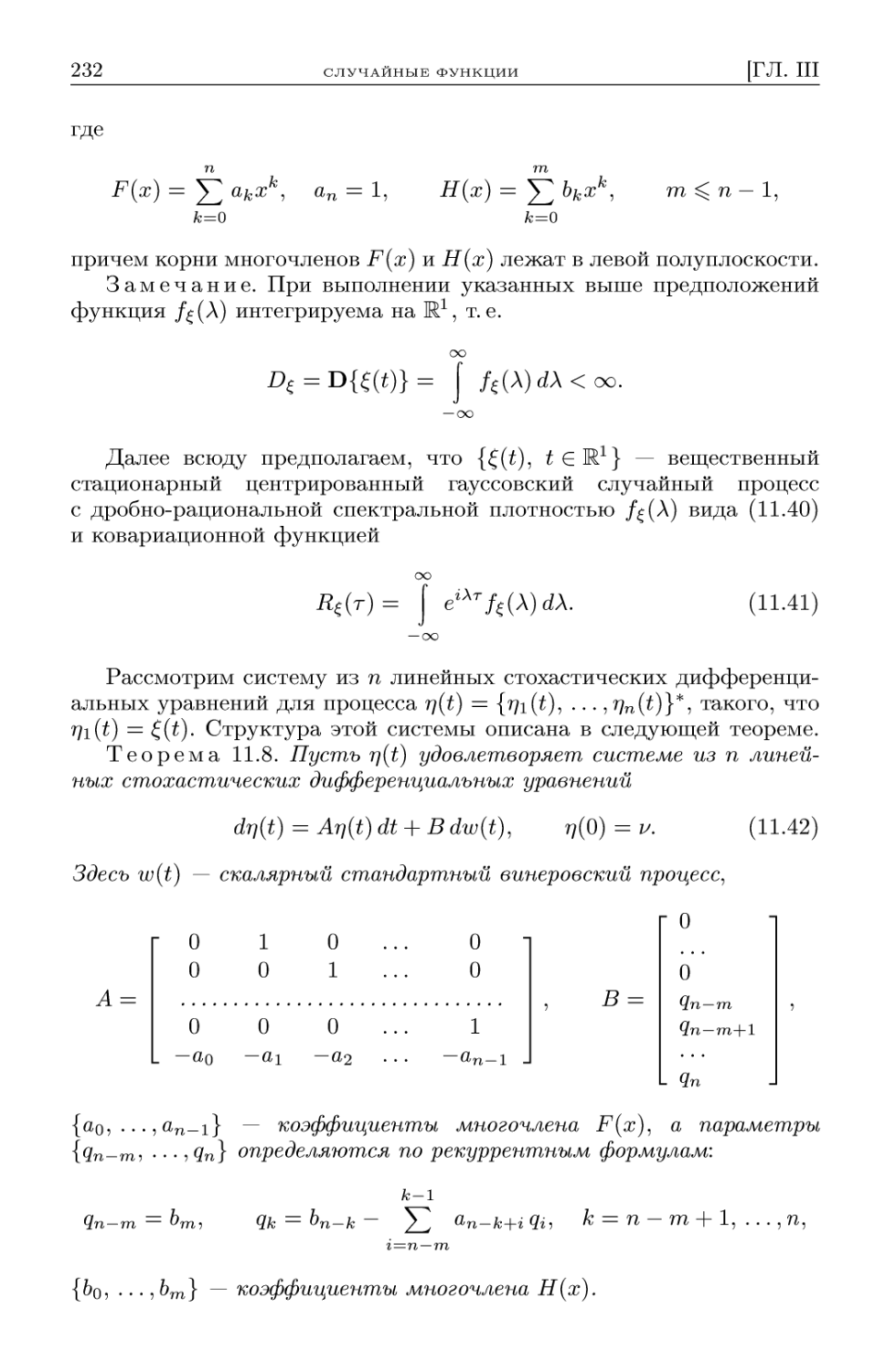

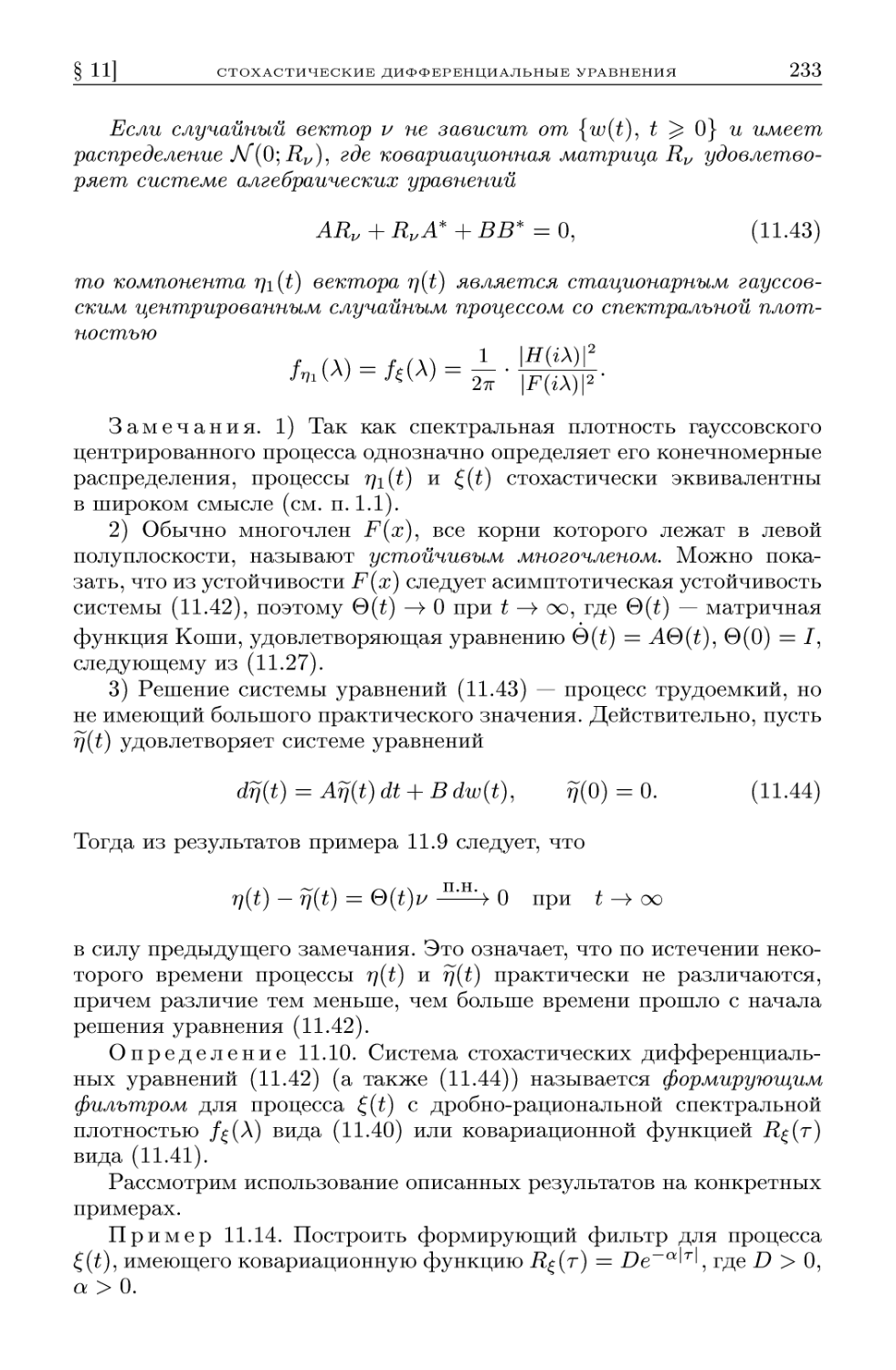

§ 11. Стохастические дифференциальные уравнения 212

11.1. Стохастический интеграл Ито B12). 11.2. Стохасти-

Стохастическое дифференциальное уравнение. Формула Ито B17).

11.3. Линейные стохастические дифференциальные урав-

уравнения B25). 11.4. Формирующий фильтр для стационар-

стационарной случайной функции B31). 11.5. Стохастические диф-

дифференциальные уравнения и диффузионные процессы B36).

11.6. Фильтр Калмана-Бьюси B39). 11.7. Задачи для само-

самостоятельного решения B45).

§ 12. Марковские случайные функции с дискретным множеством

состояний 247

12.1. Потоки событий B47). 12.2. Вероятностное описание

марковских случайных функций с дискретным множеством

значений B50). 12.3. Эргодические свойства однородных

марковских случайных функций B54). 12.4. Процессы ро-

рождения и гибели B57). 12.5. Задачи для самостоятельного

решения B62).

Глава IV. Математическое приложение 264

§ 13. Необходимые сведения из функционального анализа .... 264

13.1. Алгебры и сг-алгебры множеств B64). 13.2. Меры

(определения и свойства) B65). 13.3. Способы задания мер

B66). 13.4. Измеримые функции B70). 13.5. Интеграл Ле-

Лебега B72). 13.6. Гильбертово пространство B79). 13.7. Ря-

Ряды Фурье в гильбертовом пространстве B82). 13.8. Ортого-

Ортогональное проектирование в гильбертовом пространстве B83).

СОДЕРЖАНИЕ

§ 14. Необходимые сведения из теории вероятностей 284

14.1. Случайные события и их вероятности B84). 14.2. Слу-

Случайные величины и векторы B86). 14.3. Математическое

ожидание B90). 14.4. Последовательности случайных вели-

величин B94). 14.5. Условное математическое ожидание B96).

14.6. Гауссовские случайные величины и векторы B99).

14.7. Гильбертово пространство случайных величин с ко-

конечным вторым моментом C01). 14.8. Ортогональная сто-

стохастическая мера C03). 14.9. Стохастический интеграл по

ортогональной мере C05).

§ 15. Вычисление специальных интегралов 307

15.1. Интеграл вероятностей C07). 15.2. Интегралы от дроб-

дробно-рациональных функций C08).

Список литературы 310

Предметный указатель 312

ПРЕДИСЛОВИЕ РЕДАКТОРА

В 1973 году на факультете прикладной математики Московского

государственного авиационного института (технического университе-

университета) академиком B.C. Пугачевым была создана кафедра теории вероят-

вероятностей и математической статистики. За прошедшее время на кафедре

под научно-методическим руководством B.C. Пугачева были созданы

и прочитаны оригинальные учебные курсы по таким дисциплинам,

как «Теория вероятностей и математическая статистика», «Случай-

«Случайные процессы», «Математический анализ» и др. На суд читателя

выносится серия учебных пособий по трем названным дисциплинам,

которые отражают накопленный опыт преподавания этих дисциплин

студентам технического университета МАИ, специализирующимся

в области прикладной математики, радиоэлектроники, машинострое-

машиностроения и систем управления. Отличительной чертой данных пособий яв-

является максимально лаконичное изложение материала при достаточ-

достаточно полном описании современного состояния изучаемых предметов.

Кроме того, значительную часть пособий занимают многочисленные

примеры и задачи с решениями, что позволяет использовать эти по-

пособия не только для чтения лекционных курсов, но и для проведения

практических и лабораторных занятий. Структура изложения курсов

такова, что эти пособия могут одновременно играть роль учебника,

задачника и справочника. Поэтому пособия могут быть полезны как

преподавателям и студентам, так и инженерам.

Проф., д.ф.-м.н. А.И. Кибзун

ПРЕДИСЛОВИЕ

Содержание данного учебного пособия отражает многолетний

опыт преподавания студентам и аспирантам факультета прикладной

математики Московского государственного авиационного институ-

института (технического университета) курса теории случайных процессов,

в становлении которого решающая роль принадлежит академику РАН

B.C. Пугачеву. При подготовке учебника авторы основывались на

следующих базовых принципах:

— математически корректное изложение материала и обоснование

всех методов, используемых для решения конкретных задач;

— иллюстрирование основных теоретических положений примера-

примерами различного уровня сложности;

— более подробное рассмотрение тех моделей случайных процес-

процессов, которые в настоящее время являются наиболее важными для

решения прикладных задач.

В книге приведено значительное количество строгих определений

и аккуратных формулировок теорем. Доказательства теорем можно

найти в многочисленных учебниках по теории случайных процессов

[2,4,10,20-22,25]. Для понимания основного материала достаточно

знания курсов математического анализа, линейной алгебры и теории

вероятностей в объемах, принятых для изучения в техническом уни-

университете. Для овладения материалом в полном объеме необходимо

знакомство с основами функционального анализа (теория меры, ин-

интеграл Лебега, гильбертово пространство). Исчерпывающие сведения

по теории вероятностей содержатся в учебниках [1,19,22,25] и спра-

справочнике [9], а по функциональному анализу — в [8,13,18].

Использование всех приведенных теоретических положений про-

проиллюстрировано многочисленными примерами, снабженными подроб-

подробными решениями. В наиболее важных примерах изучаются модели и

методы исследования случайных процессов, на которых базируются

эффективные алгоритмы обработки информации, принятия решений,

анализа и прогнозирования реальных процессов в физических, биоло-

биологических, сложных технических и экономических системах. В конце

каждого параграфа приведены задачи для самостоятельного реше-

решения. Все задачи снабжены ответами, а наиболее сложные — указани-

указаниями к решению. Отметим также задачники [3,7], которые могут быть

использованы для самостоятельной проработки материала.

Наконец, для изучения были отобраны те математические модели

случайных процессов, которые имеют особое значение для постановки

и решения прикладных задач в следующих областях:

— управление сложными системами [6,15,16,23];

ПРЕДИСЛОВИЕ

— управление движением летательных аппаратов [11];

— обработка измерительной информации [20,24];

— исследование надежности систем [10];

— исследование операций и системный анализ [27];

— идентификация систем [12];

— системы массового обслуживания [5,27];

— математическая экономика и теория финансов [14,26,28].

Поэтому наряду со стандартными разделами курса (гауссовские

процессы, стационарные процессы и их преобразования, цепи Мар-

Маркова и др.) в книге присутствуют нетрадиционные разделы, посвя-

посвященные стохастическому анализу, разностным и дифференциальным

стохастическим уравнениям, оптимальному оцениванию, теории ре-

рекуррентной фильтрации Калмана-Бьюси, методам нелинейной филь-

фильтрации, теории мартингалов. Так, например, теория мартингалов

эффективно используется в настоящее время для исследования и

оптимизации процессов на финансовых рынках [26].

Книга состоит из четырех глав. В первой главе приведены основ-

основные определения и теоретические положения общего характера, необ-

необходимые для изучения остального материала, а также кратко описаны

важнейшие типы случайных процессов, применяемых для решения

прикладных задач.

Вторая глава посвящена случайным процессам с дискретным вре-

временем (случайным последовательностям). В последние годы значе-

значение этого класса случайных процессов повысилось в связи с тем,

что на смену аналоговым методам обработки информации пришли

цифровые методы, реализованные в виде компьютерных алгоритмов

и программ.

В третьей главе книги изучаются случайные процессы с непре-

непрерывным временем (случайные функции). Модели таких процессов

адекватно описывают движение механических систем в случайных

средах, распространение радиосигналов, функционирование систем

массового обслуживания, процессы изменения курсов ценных бумаг

и многое другое.

Четвертая глава имеет справочный характер и содержит сведения

по функциональному анализу и теории вероятностей, необходимые

для изучения материала в полном объеме.

При подготовке рукописи книги мы постоянно пользовались со-

советами и помощью наших коллег по кафедре «Теории вероятностей»

Московского государственного авиационного института (технического

университета) А.В. Борисова, А.В. Босова, Е.Н. Платонова и В.И. Си-

ницына, которым мы выражаем искреннюю признательность. Авторы

выражают особую благодарность К.В. Семенихину за работу по науч-

научному редактированию рукописи и подготовку оригинал-макета.

список основных

СОКРАЩЕНИЙ И ОБОЗНАЧЕНИЙ

С В — случайная величина или слу-

случайный вектор;

СП — случайная последовательность;

СФ — случайная функция;

С СП — стационарная СП;

ССФ — стационарная СФ;

ЦМ — цепь Маркова;

АР — авторегрессия;

С С — скользящее среднее;

АРСС — авторегрессия—скользящее

среднее;

М1 —множество вещественных чисел;

Ж1 — n-мерное (вещественное) евкли-

евклидово пространство;

Z — множество целых чисел;

С — множество комплексных чисел;

~z — комплексное число, сопряженное

к z G С;

Re z — вещественная часть комплек-

комплексного числа z ? С;

А* — транспонированная матрица;

А~г — обратная матрица;

/ — единичная матрица;

Б(Шп) — сг-алгебра борелевских под-

подмножеств пространства Шп;

Б ([а, Ь]) —сг-алгебра борелевских под-

подмножеств промежутка [а, Ь];

I в(х) — индикатор (индикаторная

функция) множества В\

ехр{ж} = ех — экспонента;

f(xo-) = Hm f(x) — предел слева

функции /(ж) в точке xq\

arg min fix) — точка минимума фун-

хех

кции f(x) на множестве Х\

ц(В) — мера 11 множества В]

C(N) — линейная оболочка множе-

множества N;

det[A] — определитель матрицы А;

tr[A] — след матрицы А;

тгм(х) — проекция элемента х на под-

подпространство М;

о(х) — «о-малое», т.е. функция от ж,

такая, что о(х)/х —> 0 при х —»> 0;

S(х) — дельта-функция Дирака;

1/2[а, Ъ] — гильбертово пространство

комплексных функций, интегри-

интегрируемых с квадратом по мере Ле-

Лебега на отрезке [а, 6];

Q — пространство элементарных со-

событий (исходов) ои;

Т — сг-алгебра случайных событий

(подмножеств Q);

Р{А} — вероятность (вероятностная

мера) события А;

{Q,!F, Р} — основное вероятностное

пространство;

0 — невозможное событие (пустое

множество);

F^(x) — функция распределения

вероятностей СВ ?;

Pg(x) — плотность распределения

вероятностей СВ ?;

т^ = М{?} — математическое ожи-

ожидание (среднее) СВ ?;

D% = D{?} — дисперсия СВ ?;

cov{^, 77} — ковариация СВ ? и 77;

о

? — центрированная СВ ?;

Е(Х) — экспоненциальное распреде-

распределение с параметром Л;

АГ(т] D) — гауссовское (нормальное)

распределение со средним т и

дисперсией (ковариационной ма-

матрицей) D;

Ф(х) — интеграл вероятностей (фун-

(функция Лапласа);

1-L — гильбертово пространство (цен-

(центрированных) СВ с конечным

вторым моментом;

||?|| = М{|?|2}1/2 - норма СВ ? в П\

10

СПИСОК ОСНОВНЫХ СОКРАЩЕНИЙ И ОБОЗНАЧЕНИЙ

(?? v) — скалярное произведение СВ

k и v ъЧ\

? J- г] — ортогональные СВ ? и г\ в 7i;

— гильбертово пространство,

порожденное случайной последо-

последовательностью ? = {?п};

= а{{;} — сг-алгебра, порожден-

ная СВ f;

= cr{?(s), s ^ t} — сг-алгебра, по-

порожденная случайным процессом

?(s) до момента t;

} — условное математиче-

математическое ожидание С В ту относитель-

относительно а- алгебры Q;

М{г] | ?} = М{т7 | J7*} — условное

математическое ожидание С В 77

относительно СВ ?;

Р{А | 5} — условная вероятность

случайного события А относи-

относительно случайного события В]

{?п, п G Щ — СП, заданная на Z;

{?(?), t G Т} — СФ, заданная на

промеж:утке Т С R1;

.., хп; ti, ..., tn) — n-мерная

функция распределения случай-

случайного процесса ?(?);

(ж1, ... ,жп; ti, ... ,tn) — n-мерная

плотность распределения слу-

случайного процесса ?(?);

..., An; t\, ..., tn) — n-мерная

характеристическая функция

случайного процесса ?(?);

(t) — математическое ожидание

случайного процесса ?(?);

(i — дисперсия случайного про-

процесса ?(?);

— ковариационная функция

случайного процесса ?(t);

(r) — ковариационная функция

стационарного процесса ?(?);

() — спектральная функция ста-

стационарного процесса ?(?);

Д (А) — спектральная плотность ста-

стационарного процесса ?(?);

Ф(А) — частотная характеристика

линейного стационарного преоб-

преобразования;

— ортогональная стохасти-

стохастическая мера, соответствующая

стационарному процессу ?(?);

?п — оптимальные в среднем

квадратическом (с.к.-оптималь-

(с.к.-оптимальные) оценки;

(?)t — квадратическая характери-

характеристика мартингала ?;

P(s,x,t, В) — переходная вероят-

вероятность марковского процесса;

p(s,x,t,y) — переходная плотность

марковского процесса;

P(x,t,B) — переходная вероятность

однородного марковского про-

процесса;

p(x,t,y) — переходная плотность од-

однородного марковского процесса;

Pij(si~k) — вероятность перехода ЦМ

из г-го состояния в момент s в j-e

состояние в момент ?;

р{. — вероятность перехода однород-

однородной ЦМ из г-го состояния в j-e

состояние за один шаг;

Р — {Pij} — переходная матрица

однородной ЦМ;

fti(t) — вероятность г-го состояния

ЦМ в момент t;

w(t) — винеровский процесс (процесс

броуновского движения);

A?(s, t) = ?(?) — ?(s) — приращение

случайного процесса ?(/;) на про-

промежутке (s,t];

?п ') ? — среднеквадратическая

сходимость (с.к.-сходимость);

? = l.i.m. ?п — среднеквадратический

п—>-оо

предел (с.к.-предел);

?(?) — среднеквадратическая произ-

производная (с.к.-производная);

(Р-п.н.) — почти наверное (с вероят-

вероятностью 1);

?п —'—^ ? — сходимость (Р-п.н.);

? = Km ?n (Р-п.н.) — предел с веро-

п^оо

ЯТНОСТЬЮ 1.

ГЛАВА I

ОСНОВНЫЕ ПОНЯТИЯ ТЕОРИИ

СЛУЧАЙНЫХ ПРОЦЕССОВ

В данной главе рассматриваются основные характеристики слу-

случайных последовательностей и случайных функций: конечномерные

законы распределения и моментные характеристики. Во втором пара-

параграфе главы приводится краткое описание наиболее важных классов

случайных процессов и обсуждаются их характерные особенности.

Материал данной главы является базовым для более детального изу-

изучения случайных процессов в последующих главах.

§ 1. Случайные процессы

и их вероятностные характеристики

1.1. Определение случайного процесса. Случайный процесс

является математической моделью для описания случайных явлений,

развивающихся во времени. При этом предполагается, что состоя-

состояние процесса в текущий момент времени t G Ш1 есть векторная или

скалярная случайная величина ?(t,uj). Пространство элементарных

событий (исходов) Q предполагается измеримым, т. е. на нем опре-

определена а-алгебра его подмножеств Т. Кроме того, предполагается,

что на измеримом пространстве {Q,J-} задана вероятностная мера Р,

т.е. для любого множества A G Т определена его вероятность Р{А}.

Тем самым, задано вероятностное пространство {О,^7, Р}, и понятие

случайного процесса определяется следующим образом.

Определение 1.1. Случайный процесс есть семейство (действи-

(действительных или комплексных) случайных величин {?(?,u;), t G Т}, опре-

определенных на {?7, Т, Р}, где множество параметров ГС11.

Замечание. Обычно, когда это не приводит к неясности, зависи-

зависимость ?(t,Lj) от uj не указывается и случайный процесс обозначается

просто ?(?).

Определение 1.2. Пусть to Е Т — фиксированный момент. Слу-

Случайная величина ?to(tt;) = ?(?о? °°) называется сечением случайного

процесса в точке to G Т.

12 ОСНОВНЫЕ ПОНЯТИЯ ТЕОРИИ СЛУЧАЙНЫХ ПРОЦЕССОВ [ГЛ. I

Далее мы будем рассматривать два типа случайных процессов.

Определение 1.3. Если переменная t пробегает дискретное мно-

множество значений, например, t G Z = {..., —2, —1, 0,1, 2, ... }, то слу-

случайный процесс ?(?) называется процессом с дискретным временем

или случайной последовательностью, а если t G М1 или t G [а, Ъ], где

Ъ ^ оо, то случайный процесс называется процессом с непрерывным

временем или случайной функцией.

Определение 1.4. Процесс называется действительным или

вещественным, если случайные величины ?(?,и;) являются действи-

действительными для любого ? G Т, и комплексным, если случайные величи-

величины ?(?,и;) являются комплексными для любого t E Т.

Определение 1.5. При фиксированном coq G ^ неслучайная

функция Со;0(^) =?(^?а;о)> t Е Т, называется траекторией, соответ-

соответствующей элементарному исходу ujq G Г2. Траектории называются так-

также реализациями или выборочными функциями случайного процесса.

Замечание. Случайный процесс можно трактовать как совокуп-

совокупность сечений (см. определение 1.2) или как совокупность («пучок»)

траекторий (см. определение 1.5). В различных задачах используются

оба эти описания.

Определение 1.6. Случайная функция ?(?) называется регуляр-

регулярной, если ее траектории в каждой точке t G Т непрерывны справа и

имеют конечные пределы слева.

Рассмотрим некоторые примеры, поясняющие введенные выше

определения.

Пример 1.1. Пусть случайный процесс ?(?) определен следую-

следующим образом:

Z(t) = tX, tG [0,1],

где X rsj 7Z[0,1] — случайная величина, равномерно распределенная на

отрезке [0,1]. Описать множество сечений и траекторий случайного

процесса ?(?).

Решение. Случайный процесс ?(t) является случайной функ-

функцией. При фиксированном tg ? [0,1] сечение &0(cj) = toX(uj) является

случайной величиной, имеющей равномерное распределение на отрез-

отрезке [0,t0].

Траектории процесса ?(?), т.е. неслучайные функции C^oW =

= X(uJo)t, являются прямыми линиями, выходящими из точки @,0)

со случайным тангенсом угла наклона, равным X(ljq). Случайная

функция ?(t) регулярна, так как все ее траектории непрерывны. ¦

Пример 1.2. Пусть t G [0, оо), а случайная функция ?(?) задана

следующим образом:

?(t) = Un при te[n,n + l), n = 0,1,2, ...,

где {Un, n = 0,1,2, •••} — последовательность конечных случайных

величин. Описать траектории случайного процесса ?(?). Является ли

этот процесс регулярным?

§ 1] СЛУЧАЙНЫЕ ПРОЦЕССЫ И ИХ ВЕРОЯТНОСТНЫЕ ХАРАКТЕРИСТИКИ 13

Решение. Траектории процесса ?(?), t ^ 0 — кусочно постоян-

постоянные функции, испытывающие разрывы в точках t = п = 0,1, 2, ...

По определению эти функции непрерывны справа и имеют преде-

пределы слева, равные lim^a;(t) = Un-i(uj) для всякого ио Е ?1. Поскольку

P{|C/n_i| < оо} = 1 по условию, то этот случайный процесс является

регулярным. ¦

1.2. Конечномерные распределения случайного процесса.

Определение 1.7. Пусть {?(?), t Е Т} — действительный слу-

случайный процесс и задано некоторое произвольное множество мо-

моментов времени {ti, ... ,?п} С Т. Соответствующий набор случайных

величин ?(?i), • • • ??(^п) имеет n-мерную функцию распределения

которая в дальнейшем будет называться п-мерной функцией распре-

распределения случайного процесса ?.

Совокупность функций A.1) для различных п= 1,2, ... и всех

возможных моментов времени t{ E T называется семейством конеч-

конечномерных распределений случайного процесса ?.

Определение 1.8. Если функция F^ допускает представление

Fd(r-t т • /i / I —

^ \ -L ? ' ' ' 1 ^fii и 1 ? • • • 5 °п) —

Х\ Хп

= ... pJui, ..., ип] ti, ..., tn) du\ ... dun,

— оо —оо

где p^(^i, ..., жп; ti, ..., tn) — некоторая измеримая по Лебегу

неотрицательная функция, такая, что

оо оо

р^(иъ ... ,un; tb ... ,tn)dui .. .dun =

— оо —оо

оо оо

...

то говорят, что функция распределения имеет плотность. Функция

рЛх\, ... ,жп; ti, ... ,tn) называется п-мерной плотностью распреде-

распределения процесса ?.

Следующие примеры демонстрируют нахождение конечномерных

функций распределения.

Пример 1.3. Пусть случайный процесс задан соотношением

№ = ч>№ te[o,i],

где U — некоторая случайная величина с функцией распределе-

распределения Fjj{x), a (f(t) > 0. Найти семейство конечномерных распределений

процесса ?. Имеет ли его n-мерная функция распределения плот-

плотность?

14 ОСНОВНЫЕ ПОНЯТИЯ ТЕОРИИ СЛУЧАЙНЫХ ПРОЦЕССОВ [ГЛ. I

Решение. В соответствии с определением 1.7

ъ ...,?(tn) ^ хп} =

= P{<p(U) U^xui = l,...,n} = PJC/ ^ ^у, г = 1, ..., п J =

A.2)

Если функция распределения Fjj(x) имеет плотность Pu(x)i TO

существует и плотность одномерного распределения случайного про-

процесса ?(?), поскольку для п = 1 из A.2)

следовательно, Vtlx: t) = -^\Vu\ —гт •

Ч>УЧ \<Р\Ч/

Однако при п ^ 2 n-мерная функция распределения не имеет

плотности. Действительно, в силу определения процесса ?(?) для

любых ?i, ..., tn имеет место соотношение

поэтому мера -Fii,...,tri(^i, ...,dxn) в пространстве Мп, соответству-

соответствующая функции распределения A.2), сосредоточена на прямой

S = {х е W1: хг/фг) = ... = xn/<p(tn)},

имеющей нулевую лебегову меру. Следовательно, мера i^1? ...,*„(•) син-

сингулярна по отношению к мере Лебега, и поэтому n-мерная плотность

не существует, если п ^ 2. ¦

Пример 1.4. Пусть X л Y — независимые случайные величины

с функциями распределения Fx(x) и Fy(y)- Пусть {?(?), t ^ 0} —

случайный процесс, определенный соотношением ?(t) = Xt + Y. Опи-

Описать траектории данного процесса, найти семейство конечномерных

функций распределения.

Р е ш е н и е. Выборочные функции этого процесса представляют

собой прямые линии со случайным наклоном и случайным начальным

условием при t = 0. Одномерная функция распределения случайного

§ 1] СЛУЧАЙНЫЕ ПРОЦЕССЫ И ИХ ВЕРОЯТНОСТНЫЕ ХАРАКТЕРИСТИКИ 15

процесса ?(?) при t > 0 имеет вид

оо

F^(x;t)=P{Xt + Y ^ х} = | P{Xt + Y < ж | У = y}dFY(y) =

Если лее t = 0, то i^(#; t) = .Fy(#)« Для тг-мерной функции распреде-

распределения, аналогично примеру 1.3, получаем

dFY (у)

при ti > 0, ... ,tn > 0. ¦

Пример 1.5. Пусть X, У — независимые случайные величи-

величины, имеющие гауссовское распределение Л/"@; 1/2). Случайный про-

процесс определен соотношением ?(?) = (X + Y)/t, t > 0. Вычислить

Р{|?(?)| ^ З/t} для произвольного ? > 0.

Решение. По определению F^(ж; ?) есть функция распределения

случайной величины ?(?). В силу того что X, У — гауссовские и

независимые, ?(?) = (X + У)Д такж:е имеет гауссовское распределе-

распределение, причем

Тем самым ?(?) ~ Л/"@; 1/t2), поэтому i^(x; t) = Ф(ж?), где

Функция &(z) называется интегралом вероятностей или функ-

функцией Лапласа. Итак,

РШ<)| < З/t} = F(C/t; t) - F^-3/t; t) = ФC) - Ф(-3) » 0,997. ¦

Все рассмотренные процессы относятся к случайным функциям.

Приведем примеры нахождения законов распределения случайных

последовательностей.

16 ОСНОВНЫЕ ПОНЯТИЯ ТЕОРИИ СЛУЧАЙНЫХ ПРОЦЕССОВ [ГЛ. I

Пример 1.6. Пусть случайная последовательность {?(n), n =

= 1,2, ... } такова, что ее сечения независимы в совокупности и имеют

одинаковую функцию распределения F(x). Найти семейство конечно-

конечномерных распределений последовательности ?.

Решение. По определению 1.7 с учетом независимости случай-

случайных величин ?(п) имеем

хк} =

г=1

Заметим, что все конечномерные распределения в данном случае

выражаются через одномерное распределение F(x). ¦

Пример 1.7. Пусть случайная последовательность {?(n), n =

= 0,1, 2, ... } определена рекуррентным соотношением

где {еп} — последовательность независимых в совокупности гауссов-

ских случайных величин с параметрами М{еп} = 0, D{en} = а2 > 0.

Найти одномерную функцию распределения случайной последова-

последовательности ?.

Решение. Из определения случайной величины ?(п) находим

п

?(п) = ?1 а"-1 + ... + ?„_! а + <г„ = ^ ?fc an~k.

к=1

В силу гауссовости и независимости случайных величин {?&} случай-

случайная величина ?(п) — гауссовская с параметрами mJn) = 0 и

^ <72п, если

Поэтому одномерная функция распределения имеет вид

2п если а2 = 1.

Замечание. Случайная последовательность, описанная в при-

примере 1.6, называется дискретным белым шумом. В дальнейшем эта

модель будет часто использоваться для построения более сложных

случайных последовательностей. В примере 1.7 последовательность

{sn\ является дискретным гауссовским белым шумом.

§ 1] СЛУЧАЙНЫЕ ПРОЦЕССЫ И ИХ ВЕРОЯТНОСТНЫЕ ХАРАКТЕРИСТИКИ 17

1.3. Теорема Колмогорова. Семейство конечномерных распре-

распределений является основной характеристикой случайного процесса,

полностью определяющей его свойства. Мы будем говорить, что слу-

случайный процесс задан, если задано семейство его конечномерных

распределений A.1).

Функции распределения процесса ?(?) обладают следующими свой-

свойствами.

1) О ^J F^(x\, ... ,жп; ti, ... ,tn) ^ 1 (условие нормировки).

2) Функции F^{xi, ..., жп; ?i, ... ,tn) непрерывны справа по пере-

переменным Х{.

3) Если хотя бы одна из переменных Х{ —^ — оо, то

..,жп; tb ...,tn) ->> О,

если все переменные а^ ~~^ +оо, то

4) Функции F^ixi, . ..,жп; ti, ...,tn) монотонны в следующем

смысле:

..,жп; tb ...,tn) ^ 0,

где А^ — оператор конечной разности по переменной

a /ii ^ 0, ..., /гп ^ 0 произвольны.

5) Для любой перестановки {&i, ..., fcn} индексов {1, ..., п}

6) Для любых

Определение 1.9. Свойства 5 и 6 называются условиями согла-

согласованности семейства конечномерных распределений.

Пример 1.8. Доказать справедливость свойств 1-6 для произ-

произвольного семейства конечномерных распределений.

Р е ш е н и е. Все свойства 1—6 непосредственно вытекают из со-

соответствующих свойств вероятности. Действительно, свойство 1 есть

условие нормировки для вероятности. Свойства 2 и 3 немедленно

следуют из свойства непрерывности вероятности. Свойство 4 есть

условие неотрицательности вероятности, поскольку

..,xn; h, ... ,*„) = Р{П{жг < ?(t4) < xt + /ij} ^ 0.

2 Б.М. Миллер и А.Р. Панков

18 ОСНОВНЫЕ ПОНЯТИЯ ТЕОРИИ СЛУЧАЙНЫХ ПРОЦЕССОВ [ГЛ. I

Наконец, свойства 5 и 6 являются свойствами совместной функции

распределения случайных величин {?(?i), . ..,?(?„)}. Полное доказа-

доказательство предлагается выполнить самостоятельно (см. задачу 1). ¦

Предположим, что для любого п ^ 1 и любого набора момен-

моментов времени {ti, ..., tn} С Т заданы функции F(xi, ..., хп; t\, ..., ?п),

a?i, ..., хп GM1, удовлетворяющие условиям 1—6. Является ли это

семейство функций семейством конечномерных распределений неко-

некоторого случайного процесса? Чтобы положительно ответить на этот

вопрос, необходимо построить пространство элементарных исходов ?7,

задать некоторую а-алгебру Т его подмножеств и вероятность Р

и, наконец, построить семейство функций ?(?, о;), определенных на

ТхО так, чтобы семейство конечномерных распределений процесса

?(t,u)) совпало с семейством функций F. Оказывается, что данная

процедура осуществима всегда. Этот основополагающий результат

теории случайных процессов известен как теорема Колмогорова.

Теорема 1.1 (Колмогоров). Пусть задано некоторое семейство

конечномерных функций распределения

F = {F(Xl, ...,ж„; ti, ...,*„)> xtER1, UeT, г = 1, ...,п, п > 1},

удовлетворяющих условиям 1—6. Тогда существуют вероятностное

пространство {^l,^7, P} и случайный процесс {?(?), t?T}, такие,

что семейство конечномерных распределений F^ случайного процесса

совпадает с F.

Замечание. Теорема Колмогорова вместе с установленными вы-

выше свойствами семейства конечномерных распределений показыва-

показывает, что условия 1—6 являются необходимыми и достаточными для

существования случайного процесса с заданными конечномерными

распределениями F%.

Таким образом, всегда найдется случайный процесс с заданным

семейством конечномерных распределений. Оказывается, что в общем

случае такой процесс не будет единственным. Другими словами, се-

семейство конечномерных распределений задает целый класс случай-

случайных процессов, которые в некотором смысле являются эквивалент-

эквивалентными. Рассмотрим более подробно различные подходы к определению

этого понятия.

Пусть {X(t), t G Т} и {Y(t), t G T} — два случайных процес-

процесса, определенные на одном и том же вероятностном пространстве

{?7, Т, Р} и принимающие значения в одном и том же измеримом про-

пространстве, например {М1, ^(М1)}, где Б(М}) — сг-алгебра борелевских

подмножеств Ш1.

Определение 1.10. Процессы {X(t), t G Т} и {У(?), t G Т} на-

называются стохастически эквивалентными в широком смысле, если

для любых {tb ...,?„} СТ, {Въ ...,Вп} СБ(Ш1), п = 1,2, ... выпол-

§ 1] СЛУЧАЙНЫЕ ПРОЦЕССЫ И ИХ ВЕРОЯТНОСТНЫЕ ХАРАКТЕРИСТИКИ 19

няется равенство

P{x(ti) ев,,..., x(tn) е вп} = P{Y(h) евъ..., y(tn) е вп}.

A.3)

Замечание. Условие эквивалентности в широком смысле озна-

означает, что семейства конечномерных распределений процессов X и Y

совпадают.

Определение 1.11. Если для любого t G Т

P{X(t) = Y(t)} = 1, A.4)

то процессы называются стохастически эквивалентными или просто

эквивалентными.

Введенные понятия эквивалентности связаны между собой, так

как справедливо следующее утверждение.

Теорема 1.2. Эквивалентные процессы всегда эквивалентны

в широком смысле.

Определение 1.12. Если процесс X(t) является эквивалентным

процессу Y(t), то X(t) называется версией или модификацией процес-

процесса Y{t).

Эквивалентность процессов в общем случае не означает их тожде-

тождественности. Следующий пример показывает, что два эквивалентных

процесса могут иметь совершенно различные траектории.

Пример 1.9. Пусть ?1 = [0,1],^-" — сг-алгебраборелевскихподмно-

сг-алгебраборелевскихподмножеств отрезка [0,1], Р — мера Лебега и Т = [0,1]. На вероятностном

пространстве {^l,^7, Р} определим случайные процессы {X(t), t G T}

и {Y(t), t G T} следующим образом:

fO, t/cj,

X(t, и) = 0, Y(t, и) = < при (?, и) G Т х п.

ll t uj

Показать, что процессы являются эквивалентными, однако их траек-

траектории отличаются (Р-п.н.).

Р е ш е н и е. Для некоторого фиксированного t G Т

)} = {uj:uj = t} = {t}.

Поскольку мера Лебега одноточечного множества равна нулю, то

P{X(i) = Y(t)} = l для любого teT,

т.е. процессы X{t) и Y{t) эквивалентны. Тем не менее у процессов

X(t) и Y(t) нет ни одной пары совпадающих траекторий. Действи-

Действительно, для всякого uj G ?1 в точке t* = со по условию X(t*,uj) ф

Ф Y(t*,uj), поэтому

P{cj: X(t,u) = Y(t,uj) Vt G T} = 0. ¦

20 ОСНОВНЫЕ ПОНЯТИЯ ТЕОРИИ СЛУЧАЙНЫХ ПРОЦЕССОВ [ГЛ. I

Следующее определение описывает наиболее сильный тип эквива-

эквивалентности.

Определение 1.13. Процессы {X(i), t G Т} и [Y(t), t G T} на-

называются неотличимыми, если

P{X(t) = Y{t) VteT} = 1. A.5)

Условие A.5) часто записывают также в следующем виде:

P{snp\X(t)-Y(t)\ >0} =0.

teT

При некоторых условиях, однако, определения 1.11 и 1.13 эквива-

эквивалентны. Это справедливо, например, если X{t) и Y{t) — случайные

последовательности (т.е. множество Т счетно).

Пример 1.10. Доказать, что эквивалентные случайные последо-

последовательности неотличимы.

Решение. Пусть X{t), Y(t) — эквивалентные процессы с дис-

дискретным временем t G Т = Z, тогда

~P{X(t) ф Y(i) хотя бы для одного t G Т} =

= Р{ U {X(t) ф Y(t)}\ < ? Р{*(*) Ф П*)} = 0,

teT teT

что влечет выполнение условия A.5). ¦

Таким образом, стохастически эквивалентные случайные после-

последовательности неотличимы. Для случайных функций, к сожалению,

это утверждение в общем случае несправедливо без некоторых до-

дополнительных ограничений. Тем не менее справедливо следующее

практически важное утверждение.

Теорема 1.3. Если две стохастически эквивалентные случай-

случайные функции являются регулярными (см. определение 1.6), то они

неотличимы.

Замечание. Из приведенных выше рассуждений следует, что

задание совокупности конечномерных распределений в общем случае

не позволяет заранее обеспечить выполнение некоторых требований

относительно поведения траекторий случайных функций (например,

непрерывность, монотонность, дифференцируемость и т. д.). Однако

если случайная функция регулярна или задана конструктивно некото-

некоторым соотношением, то мы можем определить вероятности достаточно

сложных событий, связанных с поведением ее траекторий.

Пример 1.11. Предположим, что случайная функция задана со-

соотношением ?(?) = X2 + 2tY + ?2, t ^ 0, где X, Y — независимые

случайные величины, имеющие гауссовское распределение Л/"@;1).

Найти вероятности следующих событий:

§ 1] СЛУЧАЙНЫЕ ПРОЦЕССЫ И ИХ ВЕРОЯТНОСТНЫЕ ХАРАКТЕРИСТИКИ 21

1) А\ = {?(?) монотонно не убывает};

2) А2 = {?(?) неотрицательна};

3) Аз = {?(?) = 0 хотя бы для одного t G ?>}, где D С [0, оо) —

некоторое конечное или счетное подмножество;

4) т44 = {?(?) = 0 хотя бы для одного t G [0, оо)}.

Решение. 1) Поскольку траектории ?(?) дифференцируемы по ?,

то условие их монотонности есть ?'(?) = 2 У + 2? ^ 0, ? ^ 0. Для вы-

выполнения этого условия необходимо и достаточно, чтобы У была

неотрицательной. Таким образом, P{t4i} = Р{У ^ 0} = 1/2.

2) Условие неотрицательности траекторий ?(?) выполняется, если

либо У > 0, либо У ^ 0, но |У| ^ \Х\. Таким образом, в силу незави-

независимости X, Y и симметрии их законов распределения получаем

Р{А2} = P{Y > 0} + Р{У < 0, \Y\ < |Х|} = 1/2 + 1/4 = 3/4.

3) Р{^3} = Р{ U Ш*) = °}} < Е р{^(*) = °>- Для любого

teD teD

сированного t справедливо

= 0} = {X2 + 2?У + ?2 = 0} = {(X, У) G Б},

где множество В = {(х,у) G М2 : ж2 + 2?г/ + ?2 = 0} представляет собой

параболу и поэтому имеет нулевую меру Лебега в Ш2. Теперь, учиты-

учитывая, что совместное распределение случайных величин X, У имеет

плотность р(ж,у), получаем

= 0} = Р{(Х,У) G Б} = Jp(s,2/)<fad2/ = 0.

Далее, поскольку множество D не более чем счетно, Р{^4з} = 0.

4) Событие А/± состоит в том, что функция ?(?) имеет на [0, оо) по

крайней мере один корень, что выполняется, если одновременно У ^ 0

и |У| ^ |Х|. Поэтому Р{^4} = Р{^ ^ 0, |У| ^ |Х|} = 1/4. ¦

1.4. Моментные характеристики случайного процесса.

Моментные характеристики случайного процесса задают его простей-

простейшие свойства и вычисляются с помощью конечномерных распреде-

распределений различных порядков. Пусть ?(?) — скалярный (вещественный)

процесс.

Определение 1.14. Неслучайная функция mJt), t ET, опреде-

определяемая соотношением

22 ОСНОВНЫЕ ПОНЯТИЯ ТЕОРИИ СЛУЧАЙНЫХ ПРОЦЕССОВ [ГЛ. I

называется математическим ожиданием процесса ?(t) или его сред-

средним значением. Если m^{t) = 0 при всех t Е Т, то процесс называется

центрированным.

Определение 1.15. Неслучайная функция D^(t), t Е Т, опреде-

определяемая соотношением

х2 dFt(x; t) -

называется дисперсией (или дисперсионной функцией) процесса

Замечание. При каждом t E T математическое ожидание и

дисперсия m^(t), D^(t) процесса ?(?) суть математическое ожидание

и дисперсия его сечения в точке t E Т.

Определение 1.16. Неслучайная функция

определяемая соотношением

ОО ОО

= J J

— oo —oo

называется ковариационной функцией процесса

Замечания. 1) При любых t,r ?Т функция Щ{Ь,т) численно

равна ковариации сечений случайного процесса ?t(w) и ?г(с<;) в точках

?, т Е Т и характеризует степень линейной зависимости между сече-

сечениями. Для вычисления Щ(Ь,т) необходимо знать двумерное распре-

распределение Fg(xi,X2'-> t,r) процесса ?(?). Заметим также, что

), t ET.

Из неравенства Коши—Буняковского следует, что для существова-

существования rrig(t), D^(t) и Щ(г,т) при всех ?,т ЕТ достаточно выполнения

условия

2} <оо VtET. A.6)

СЛУЧАЙНЫЕ ПРОЦЕССЫ И ИХ ВЕРОЯТНОСТНЫЕ ХАРАКТЕРИСТИКИ 23

2) Если распределения F^{x\ i) и F^{x\^X2] t,r) имеют плотности

распределения р^(х\ t) и p^(xi1X2'1 t,r), то

= хр^х] t)dx, D^{t) =

,т) =

— oo — oo

Определение 1.17. Случайный процесс {?(?), t G T}, удовлетво-

удовлетворяющий условию A.6), называется процессом с конечными момента-

моментами второго порядка или гильбертовым случайным процессом.

Определение 1.18. Пусть ^(t) = X(t)-\-iY(t) — комплексный

процесс, где Х(?), Y(t), t G T — некоторые действительные случайные

процессы, а г2 = — 1. Если

м{|?(*)|2} = м{е(*Ш} = M{x2(t) + Y2(t)} < оо Vi е т,

то процесс ?(?) называется комплексным гильбертовым процессом.

Функция

,г) =

где { • } означает комплексное сопряжение, называется ковариацион-

ковариационной функцией комплексного случайного процесса ?(?).

Пример 1.12. Пусть ?(t) = Xip{t), t G T, где X — действительная

случайная величина со средним тпх и дисперсией ?>х, a ip(t) —

неслучайная функция на Т. Найти mAt), D^(t) и R^(t^r).

Решение. В соответствии с определениями 1.14-1.16 имеем

€ = M{X} <p(t) = mx<p(t),

= cav{X<p(t),X<p(T)} = cav{X,X}<p(t)<p(T) = Dx

Следующий пример является обобщением предыдущего.

п

Пример 1.13. Пусть ?(t) = ^Хт(Ь), t G T, где Х{ — действи-

тельные некоррелированные случайные величины с известными пара-

параметрами {mx., Dx-}> a Wi(t)} — заданные на Т детерминированные

функции. Найти m^(t), D^(t) и Rg(t,r).

24 ОСНОВНЫЕ ПОНЯТИЯ ТЕОРИИ СЛУЧАЙНЫХ ПРОЦЕССОВ [ГЛ. I

Решение. В соответствии с определениями 1.14—1.16 имеем

г=1

г=1

Так как Х±, ..., Хп — некоррелированные случайные величины, т. е.

cov{JQ, Xj} = 0 при г / j, то

г=1

Пример 1.14. Найти необходимое и достаточное условие, при

котором существует процесс {?(?), ? G Т} с характеристиками

M{?(i)} = m€(«), cov{^(i),^(r)} = Щ(г, г), A.7)

где mAt), Rg(t,r) — заданные вещественные функции.

Решение. Найдем сначала необходимое условие. Пусть ?(?) —

процесс с характеристиками A.7). Тогда для любых наборов

{ti, ..., tn} С Т и {zi, ..., zn} С С справедливо соотношение

^L EE{(o(i)}^ о,

г=1 j

т.е. функция Щ{Ь,т) удовлетворяет условию неотрицательной опре-

определенности:

ff , ...,*„}ст, У{гь ...,2„}сС.

A.8)

Докажем теперь, что условие A.8) является в то же время и доста-

достаточным для существования случайного процесса с моментными харак-

характеристиками A.7). Действительно, условие A.8) означает, что матрица

К = {Щ(и, tj)}ij=i: ...?n является неотрицательно-определенной, по-

поэтому существует функция F^(x\, ... ,жп; ti, ... ,tn) n-мерного гаус-

совского распределения N (га; X), где га = {m^(ti)}i=i^ ...?n (см. п. 14.6).

§ 1] СЛУЧАЙНЫЕ ПРОЦЕССЫ И ИХ ВЕРОЯТНОСТНЫЕ ХАРАКТЕРИСТИКИ 25

Как нетрудно проверить, построенная система конечномерных рас-

распределений удовлетворяет условиям 1-6 из п. 1.3. Поэтому в силу

теоремы Колмогорова существует случайный процесс {?(?), t G Т},

имеющий указанное семейство гауссовских распределений и, в част-

частности, обладающий характеристиками A.7). ¦

Замечание. Процесс, рассмотренный в примере 1.14, называется

гауссовским случайным процессом. Свойства таких процессов более

детально рассматриваются в следующем параграфе.

Определение 1.19. Пусть заданы два комплексных процесса

), r?(?), t G Т. Детерминированная функция

t,r еТ,

называется взаимной ковариационной функцией случайных процессов

f и 77.

Замечание. Функция R^^t^r) существует, если ?(?) и rj{t) —

гильбертовы процессы.

Определение 1.20. Пусть ф) = {fi(t), ...,?n(t)}* G W1 — век-

векторный случайный процесс. Детерминированная n-мерная вектор-

функция TnJt) G Mn, t G Т, определяемая соотношением

называется математическим ожиданием векторного случайного

процесса ?(?).

Детерминированная матричная функция

,г) =

), t, т 6 Т,

называется ковариационной функцией векторного случайного процес-

саф).

Замечание. Для существования m^(i) и Щ(t,т) при всех t,r ? Т

достаточно выполнения условия

М{\ф)\2} = М{\Ш\2 + • • • + |?п(*)|2} < оо Vt G Т. A.9)

Пример 1.15. Пусть ф) = G(i)U, t G Т, где U G Mm — некото-

некоторый случайный вектор с параметрами М{С/} = mjj, cov{C/, U} = i?[/,

a G(t) — детерминированная матричная функция размера п х m.

Найти m^t), Щ(г,т).

26 ОСНОВНЫЕ ПОНЯТИЯ ТЕОРИИ СЛУЧАЙНЫХ ПРОЦЕССОВ [ГЛ. I

Решение. В соответствии с определением 1.20

Ъ г) = cow{G(t)U, G(r)U} = G(t) cov{?/, U} G*(r) = G(t)Rv G*(t),

а ковариационная матрица D^(t) сечения ?(?), t G T, имеет вид

Определение 1.21. Пусть {?(?), t G T} — действительный

случайный процесс. Детерминированная вещественная функция

?7i^(ti, ..., tk), ti, ..., tk G T, определяемая соотношением

называется смешанным моментом порядка к случайного процес-

процесса ф).

Определение 1.22. Пусть {?(?), t G Т} — действительный

случайный процесс. Детерминированная комплексная функция

Ф^(^1, ..., Zjt; ti, ..., tjt) вещественных переменных zi, ..., Z&, опреде-

определяемая для произвольного набора ?i, ..., tk G Т соотношением

= \

называется характеристической функцией к-мерного распределения

процесса ?,(t).

Замечание. Из курса теории вероятностей известно, что харак-

характеристическая функция k-vo порядка позволяет восстановить соответ-

соответствующую /с-мерную функцию распределения, поэтому эти характе-

характеристики при описании вероятностной структуры случайного процесса

являются взаимозаменяемыми (см. п. 14.6).

Пример 1.16. В условиях примера 1.12 найти характеристиче-

характеристическую функцию процесса ?(?), если дополнительно известно, что X —

гауссовская случайная величина.

§ 1] СЛУЧАЙНЫЕ ПРОЦЕССЫ И ИХ ВЕРОЯТНОСТНЫЕ ХАРАКТЕРИСТИКИ 27

к

Решение. Пусть т\ = ^ zj?,(tj)i тогда в силу ?(tj) = X<p(tj) полу-

к j=i

чаем г] = X ^ Zj(p(tj), поэтому г\ — гауссовская случайная величина

i=i

со средним и дисперсией:

mr1 = mx ? *М*з)> А> = ^х ( ?

Отсюда получаем выражение для характеристической функции:

r7} = exp

где ттт,^, Djj определены в A.10) и учтено, что для гауссовской случай-

случайной величины г] при любом А ЕЁ1 справедливо (см. п. 14.6)

Замечание. Выше был введен в рассмотрение белый шум с дис-

дискретным временем, т. е. последовательность центрированных неза-

независимых и, следовательно, некоррелированных случайных величин.

Для случая непрерывного времени по аналогии вводится понятие

белого шума как процесса ?(?) с моментными характеристиками

m^t) = 0, Щ(Ь, s) = a2S(t - s),

где S(r) — дельта-функция Дирака (см. п. 13.5). Очевидно, что

Щ(г,в) = 0, если t ф s, т.е. сечения этого процесса, даж:е при очень

близких t и s, некоррелированы. Однако ?(t) не является гильбер-

гильбертовым случайным процессом, так как D^(t) = R^(t^i) = оо при всех

t G Т. Таким образом, белый шум с непрерывным временем физически

нереализуем, однако он является удобной математической моделью

для описания динамических систем, функционирующих в присут-

присутствии постоянно действующих случайных возмущений (см. гл. III).

1.5. Задачи для самостоятельного решения.

1. Доказать свойства 1-6 конечномерных распределений A.1).

2. Доказать свойства 1-6 для семейства конечномерных распределений,

найденных в примерах 1.3, 1.4.

3. В условиях примера 1.4 построить пучок траекторий процесса ?(?),

если X и Y распределены равномерно на отрезках [—1,0] и [0,1] соответ-

соответственно.

28 ОСНОВНЫЕ ПОНЯТИЯ ТЕОРИИ СЛУЧАЙНЫХ ПРОЦЕССОВ [ГЛ. I

4. Доказать, что для существования m^(t), D^(t), Щ(г,т) при всех

t,r Е Т достаточно, чтобы выполнялось условие М{|?(/;)|2} < оо Wt ? Т.

Указание. Воспользоваться неравенством Коши-Буняковского.

5. Доказать, что D^(i) = R^(t,t).

6. Пусть в примере 1.4 X и У имеют плотности распределения рх(х)

и pY(y)- Найти двумерную плотность распределения процесса ?(?). Пока-

Показать, что распределения порядка к ^ 3 плотности не имеют.

Указание. Воспользоваться формулой преобразования плотности при

невырожденном преобразовании случайных величин. Показать, что мера

совместного распределения {?(?i),?(?2), • • • 5?(?&)}> & ^ 3, сосредоточена на

некотором линейном подпространстве размерности 2.

Ответ. pJx!,x2; t!,t2) = — Pxlx! - -^—^ ) pYl -^—^ ) для

моментов ^2 > t\.

7. Пусть в примере 1.13 случайные величины Xi являются независимы-

независимыми и гауссовскими с распределением А/"@; 1). Найти F^(x; t).

Указание. Определить математическое ожидание и дисперсию про-

процесса ?(?).

8. Пусть ?(?) = Xt2 + Yt, t > 0 — случайный процесс, где X, Y — неза-

независимые случайные величины с гауссовским распределением ЛА(О; 1). Найти

вероятность того, что траектория монотонно не убывает.

Ответ. Р{?(?)—неубывающая функция} = Р{Х ^ О, У ^ 0} = 1/4.

9. В условиях предыдущей задачи найти вероятность случайного собы-

события А = {min?(?) < 0).

Lt>o v у J

Ответ. Р{А} = Р{Х >0, Y < 0} + Р{Х < 0, Y > 0} = 1/2.

10. Случайный процесс задан соотношением ?(t) = X + at, t > 0, где

X — случайная величина с непрерывной функцией распределения,

а а>1 — детерминированная постоянная. Пусть D С [0, оо) — некоторое

конечное или счетное подмножество. Найти вероятности событий:

1) Р{?(?) = 0 хотя бы для одного t E D};

2) Р{?(?) = 0 хотя бы для одного t e [0,1]}.

Ответ. 1) 0; 2) Р{-а ^ X ^ 0}.

11. Найти ковариационную функцию процесса ?(?) = Xcos(/; + y), где

X, У независимы, X имеет распределение ЛГ(О; 1), а У имеет равномерное

распределение на [—тг,тг].

Ответ. Щ (/;, г) = cos(t — т).

12. Найти математическое ожидание и ковариационную функцию ком-

комплексного случайного процесса ?(t) = UelVt, где С/, V — независимые слу-

случайные величины, М{[/} = 0, D{t/} = D, а случайная величина У рас-

распределена по закону Коши с плотностью вероятности Рл/(х) = —,

7г(а2 + ж2)

где а > 0.

Указание. Воспользоваться табличным интегралом — dx =

J о;2 + ж2

о;

Ответ. m^(t) = 0, Щ(Ь,т) = De"a|t"r|.

2] ОСНОВНЫЕ КЛАССЫ СЛУЧАЙНЫХ ПРОЦЕССОВ 29

§ 2. Основные классы случайных процессов

2.1. Гауссовские случайные процессы.

Определение 2.1. Действительный случайный процесс {()

t G Г} называется гауссовским, если его характеристическая функция

имеет вид

fc к к

= ехр(г j: *;ш^-) - J Е Е ЗДЛ)^), B.1)

где Zi, ..., Zk — произвольные вещественные числа, ?i, ..., tk G T, a

Характеристическую функцию молено представить в виде

Фе(;г; tb ..., tfe) = exp(iz*m^ - \г*Щг} , B.2)

где z = {zb ...,zk}*, m^ = {m^(ti), ... ,m^(tk)}* ш Щ {R(U

Как уже говорилось ранее, характеристическая функция полностью

определяет распределение совокупности случайных величин, и тем

самым задано и полное семейство конечномерных распределений.

Замечания. 1) Из курса теории вероятностей известно, что

гауссовский случайный вектор г\ = {771, ..., т]к}* с математическим

ожиданием m и ковариационной матрицей R^ имеет плотность рас-

распределения р^х) тогда и только тогда, когда матрица R^ — невыро-

невырожденная, т.е. det^^] > 0. В этом случае

Таким образом, если матрица Rg = {R^(U,tj)}ij=i^,^k полож:ительно

определена, то совместное распределение сечений {?()?()}

имеет плотность вероятности

р^х; *!,..., tk) = B7T)h

30 ОСНОВНЫЕ ПОНЯТИЯ ТЕОРИИ СЛУЧАЙНЫХ ПРОЦЕССОВ [ГЛ. I

Связь между характеристической функцией и плотностью распреде-

распределения к-го порядка имеет вид

рЛх] ?i, ..., tk) = Bтг)~ е~гх ^Ф^(г; ?i, ..., tk) dz.

Если же det[^] =0, то это означает, что сечения {?(?].), ...,?(?&)}

линейно зависимы, а их совместное распределение F^(x; ?1, ...,?&)

плотности не имеет.

2) Нетрудно проверить, что семейство конечномерных гауссов-

ских распределений, соответствующее семейству характеристических

функций B.2), удовлетворяет условиям 1-6 теоремы Колмогорова

(см. п. 1.3). Таким образом, произвольный набор {?(?i), ••-,?(?&)}

сечений гауссовского случайного процесса является случайным век-

вектором с гауссовским распределением. Подчеркнем также, что все эти

распределения согласованы (в смысле определения 1.9).

3) Из определения гауссовского процесса следует, что семейство

его конечномерных распределений полностью определяется двумя

моментными характеристиками: математическим ожиданием и кова-

ковариационной функцией.

Пример 2.1. Пусть Х\, ..., Хп — совокупность случайных вели-

величин, совместное распределение которых — гауссовское. Показать, что

случайный процесс

где /L(t) — некоторые детерминированные функции, является гауссов-

гауссовским. Найти математическое ожидание и ковариационную функцию

процесса ?(?).

Р е ш е н и е. Для некоторого набора моментов времени \t\, ..., ?&}

найдем характеристическую функцию совместного распределения се-

сечений {?(?i)? ...,?(?&)}. По определению

к к п

M{exp(» ??(*,-)*,•)} ={(

j l

п к

' / 1 / J /V.7/

/ = 1 7 = 1 ' ' " Х / = 1

§ 2] ОСНОВНЫЕ КЛАССЫ СЛУЧАЙНЫХ ПРОЦЕССОВ 31

к

где а^ = ^ fi(tj)zj- Поскольку совместное распределение случайных

i=i

величин {Xl, ... , Хп} является гауссовским, то

= 1 i = lm=l

Далее, подставляя выражения для а^ находим

1=1 j=i

п п к к

J2 J2 cov{X/5 Xm}a/am =

/ = lm=l

где

= Е Е

1 = 1 га=1

Таким образом, процесс ^(t) является гауссовским, поскольку его

характеристическая функция удовлетворяет определению 2.1. Ко-

Конечномерное распределение к-го порядка в точках {ti, ... ,?&} имеет

плотность, если матрица R^ = {cov{?(?^), ?(^j)}}*,j=i, ...?fc положитель-

положительно определена. ¦

Приведем пример гауссовского процесса, не имеющего плотности

распределения к-го порядка (к ^ 2).

Пример 2.2. Найти плотность одномерного распределения гаус-

гауссовского случайного процесса

где X — случайная величина с гауссовским распределением Л/"@; сг2),

а > 0. Показать, что ? не имеет плотности распределения к-го порядка

при к ^ 2.

Р е ш е н и е. Случайная величина ?(?) имеет гауссовское распреде-

распределение J\f(t; а2). Поэтому в силу a > 0 распределение первого порядка

случайного процесса ?(?) имеет плотность

32 ОСНОВНЫЕ ПОНЯТИЯ ТЕОРИИ СЛУЧАЙНЫХ ПРОЦЕССОВ [ГЛ. I

Однако уже распределение порядка к = 2 не имеет плотности, так как

матрица ковариаций

вырождена. Отсутствие плотности очевидно, поскольку случайные

величины ?(?i), ?(?2) связаны соотношением ?(^2) = ?(?i) + ?2 — ?1 и,

следовательно, их совместное распределение в Ш2 сосредоточено на

множестве {(ж1, жг): ж 2 = х\ + ?2 — ?i}, имеющем нулевую меру Лебе-

Лебега. Для случая /с > 2 аналогичное рассуждение показывает отсутствие

плотности распределения. ¦

Следующий пример демонстрирует гауссовский процесс, у которо-

которого все конечномерные распределения имеют плотность.

Пример 2.3. Показать, что существует гауссовский случайный

процесс {?(?), t ^ 0} с характеристиками

M{?(i)} = 0, cov{?(i), ?(s)} = min (t, s),

причем все его конечномерные распределения имеют плотность.

Решение. Если функция Щ(г, s) = min(t, s) является неотри-

неотрицательно-определенной, то существование гауссовского процесса ?(?)

с mJt) = 0 и ковариационной функцией Rg(t,s) следует из приме-

примера 1.14 и его решения. Если же -R^(t, s) — положительно-определенная,

то конечномерные распределения процесса ?(?) (в предположении

гауссовости) имеют плотность распределения.

Функция R^(t^ s) = min(t, s) будет полож:ительно-определенной, ес-

если для любых различных моментов времени 0<?i< ?2 <...<?&

ковариационная матрица R% вектора ? = {?(?i), ?(^2), •••? ?(?&)}*? име-

имеющая вид

tl t2 ... tfc

является пол ожительно-опреде ленной. Последнее означает, что

z*R^z > 0 для всякого ненулевого вектора z = {zj., ..., Zk}* G Шк. Для

доказательства этого факта рассмотрим функцию

к

где /[o,ti](s) ~~ индикаторная функция отрезка [0,^]. В силу того что

все ti > 0 различны, a Z{ не равны нулю одновременно, функция /(s)

не равна нулю тож:дественно. Поэтому

при

§ 2] ОСНОВНЫЕ КЛАССЫ СЛУЧАЙНЫХ ПРОЦЕССОВ 33

Тогда

* к к *

j \f(s)\2 ds = J2J2 zizj\hM]is)I[^,tj]^S) ds =

0 i=lj=l о

к к

i,^-) = г*Щг > 0,

что и означает положительную определенность ковариационной

матрицы Rg. Таким образом, совместное распределение сечений

?(?]_), ... ,?(?&) гауссовского процесса ?(?) имеет плотность. ¦

Определение 2.2. Гауссовский случайный процесс {?(?), ? ^ 0}

с непрерывным временем, моментными характеристиками

М{?(?)} = 0, cov{?(t), e(s)} = min(t, s), t, О 0,

и выходящий из нуля, т.е. ?@) = 0, называется стандартным вине-

ровским процессом (или процессом броуновского движения).

Этот процесс обладает многими замечательными свойствами и бу-

будет подробно изучаться в главе, посвященной случайным функциям.

Здесь мы приведем только некоторые его свойства, которые молено

вывести непосредственно из определения 2.2.

Пример 2.4. Показать, что приращения процесса броуновского

движения на непересекающихся промежутках времени независимы, а

также найти распределение произвольного приращения.

Р е ш е н и е. Прежде всего заметим, что совокупность приращений

процесса броуновского движения

где 0 = to < ti < ... < tk и ?(to) = O, имеет гауссовское распределе-

распределение в силу гауссовости случайного вектора {?(?].),?(?2M •••>?(?&)}*•

Поэтому для доказательства независимости приращений достаточно

установить их некоррелированность. Итак, для моментов времени

U < tj верно соотношение

cov{?(?,) - ?(t,_i), ?(t,-) - ?(tj-i)} =

_i, tj-i) = 0,

что означает некоррелированность приращений процесса ?(?) на про-

промежутках [ti-i^ti] И [tj-i,tj].

Как уже отмечалось, приращение ?(?) — ?(s) имеет гауссовское

распределение. Поэтому

-a|), B.3)

3 Б.М.Миллер и А. Р. Панков

34 ОСНОВНЫЕ ПОНЯТИЯ ТЕОРИИ СЛУЧАЙНЫХ ПРОЦЕССОВ [ГЛ. I

так как М{?(?) - f (s)} = 0 и D{f(?) - f(s)} = t + s - 2min(?, s) =

= \t-s\. Ш

Пример 2.5. Найти плотность конечномерного распределения

процесса броуновского движения.

Решение. Рассмотрим приращения процесса броуновского дви-

движения:

т = f (*i) - ?(*о), т = ф2) - f (*i), ..., щ = ?(tk) - e(tfc-i),

где 0 = to < t\ < . • • < tk. Поскольку ?(?o) = 0, то

€(ti) = Vu f(*2) = 771+772, •••' ^fe) =771+ --- + 77fe.

Пусть p (•) — плотность распределения вектора rj = {771, ..., T7&}*,

a PrjX') ~ плотность распределения приращения гц. Тогда плотность

распределения вектора ? = {?(?].), ..., ?(^fc)}* равна

где первое равенство следует из того, что якобиан преобразования

V ^ ? равен по модулю 1, а второе получено с учетом независимости

случайных величин 771, ..., щ. Тогда из B.3) следует

1

, хк- tu ..., tk) = П /о . в *1*<-*<-11 , B.4)

где to = 0 и жо = 0. ¦

В приложениях весьма часто приходится иметь дело с п-мерными

гауссовскими процессами, где п > 1. По аналогии с введенным ра-

ранее определением 2.1 мы можем назвать процесс {?(?) Gln, ? G Т}

гауссовским, если при любых ?i, ..., tk G Т, /с ^ 1 (n x /с)-мерный слу-

случайный вектор ту = {C*(?i), ••• ? ?*(?&)}* имеет гауссовское (n x /^-мер-

/^-мерное распределение. Все свойства такого процесса полностью опре-

определяются n-мерной функцией математического ожидания mAt) и

(п х п)-мерной (т.е. матричной) ковариационной функцией (

которая вычисляется следующим образом:

, a) =

§ 2] ОСНОВНЫЕ КЛАССЫ СЛУЧАЙНЫХ ПРОЦЕССОВ 35

2.2. Случайные процессы с конечными моментами второго

порядка. Многие прикладные задачи в области физики и техники

допускают решение, основанное на использовании лишь первых двух

моментных характеристик случайного процесса — математического

ожидания и ковариационной функции. Это тем более удобно, по-

поскольку эти моментные характеристики можно достаточно просто

восстановить, обрабатывая статистические данные. В данном пункте

излагаются основные свойства процессов с конечными моментами

второго порядка (гильбертовых процессов), которые будут постоянно

использоваться в последующем.

В соответствии с определением 1.18 мы рассматриваем комплекс-

комплексные процессы, представимые в виде

?(t) = X(t) + iY{t), t<=T,

где X(t),Y(t) — действительные случайные процессы с конечными

моментами второго порядка. В дальнейшем для простоты предпола-

предполагается, что М{?(?)} = 0 для всех t Е Т.

Определение 2.3. Ковариационная функция процесса ?(t) име-

имеет вид

где z означает комплексную величину, сопряженную к z.

К классу гильбертовых процессов относятся рассмотренные в пре-

предыдущем пункте гауссовские процессы и, в частности, процесс

броуновского движения. Следующий процесс также является гиль-

гильбертовым.

Пример 2.6. Пусть случайная функция ф) = ие^шг+<р\ t Е М1,

где U — действительная случайная величина с М{?/} = О, D{C/} =

= D < оо, а случайная величина ip не зависит от U и распределена

произвольным образом на [0,2тг]. Показать, что случайная функция

Ф) является гильбертовым процессом, и определить ее моментные

характеристики.

Решение. В силу независимости случайных величин U и ср

= о,

оо.

= M{U2} = D<

Таким образом, ?(?) — действительно гильбертов процесс. Определим

его ковариационную функцию

36 ОСНОВНЫЕ ПОНЯТИЯ ТЕОРИИ СЛУЧАЙНЫХ ПРОЦЕССОВ [ГЛ. I

Ковариационная функция является неотрицательно-определен-

неотрицательно-определенной, т. е. для любых ti, ..., tn G Т и произвольного набора комплекс-

комплексных чисел {zi, ..., zn}, п ^ 1, имеет место неравенство

Это соотношение получается следующим образом:

О ^ DJX: ZiS(ti)} = Е Е ZiZjcovtfiU),^)} = ? ? Zi

i=l i=l j = l г=1 j = l

Приведем основные свойства ковариационной функции, которые

непосредственно вытекают из свойства неотрицательной определен-

определенности B.5).

Теорема 2.1. Ковариационная функция R^(t,s) гильбертова

случайного процесса {?(?), t G Т} обладает следующими свойст-

свойствами:

1) Щ(г,г) = D^(t) ^ 0 для всех ? G Т;

2) ковариационная функция является эрмитовой, т. е. удовле-

удовлетворяет условию

?i) V?b?2 GT;

3) ковариационная функция удовлетворяет неравенству Коши-

Буняковского

?2) V?b?2 G T;

4) d/ш всех ?ь?2,?з ? ^ имеет место неравенство

?2)]. B.6)

Если даны два гильбертовых случайных процесса, то молено

определить их взаимную ковариационную функцию (см. определе-

определение 1.19).

Замечание. Если ?(i) = X(t) + гУ(?), где X(i), Y(t) — центри-

центрированные действительные процессы с конечными дисперсиями, то

, s) = M{(X(t) + iY(t))(X(s) - iY(s))} =

= Rx(t, s) + RY(t, s) - i[RXY(t, s) - RYX(t, s)}.

§ 2] ОСНОВНЫЕ КЛАССЫ СЛУЧАЙНЫХ ПРОЦЕССОВ 37

Теорема 2.2. Для всякой неотрицательно-определенной функ-

функции R(t, s), ?, s G T существует гильбертов случайный процесс {?(?),

t Е Т} с ковариационной функцией R^(t, s) = R(t, s).

Замечание. Для действительной ковариационной функции ре-

результат теоремы вытекает из примера 1.14. В этом случае процесс ?(?)

можно выбрать действительным и гауссовским, поскольку заданная

ковариационная функция обладает свойством неотрицательной опре-

определенности.

Класс ковариационных функций обладает следующими свойства-

свойствами замкнутости относительно ряда операций.

Теорема 2.3. Пусть R^-, R%2 — ковариационные функции неко-

некоторых случайных процессов, определенных на одном и том же

множестве Т. Тогда a\R^ + a^it^ при а\,а^ ^ 0 также является

ковариационной функцией некоторого гильбертова процесса.

Теорема 2.4. Пусть {R^n(t,s), п = 1,2, ...} — последователь-

последовательность ковариационных функций некоторых гильбертовых случайных

процессов, определенных на одном и том же множестве Т. Тогда

если R^n (t, s) —> R(t, s) при п —> оо для всех t,s G T, mo R(t, s) таксисе

является ковариационной функцией некоторого гильбертова случай-

случайного процесса.

Замечание. Доказательство этих теорем становится очевидным,

если принять во внимание, что при сложении ковариационных функ-

функций с неотрицательными весами и при предельном переходе свойство

неотрицательной определенности сохраняется.

Поведение траекторий гильбертовых процессов определяется свой-

свойствами его ковариационной функции лишь в некотором усредненном

смысле. Подробно свойства траекторий этого класса процессов (непре-

(непрерывность, дифференцируемость и интегрируемость) рассматривают-

рассматриваются в гл. III.

Заметим, что линейная комбинация гильбертовых процессов так-

также является процессом этого типа.

Пример 2.7. Пусть ?(?), rj(t) — определенные на Т гильбертовы

процессы. Показать, что

\a

2

ос,

также является гильбертовым процессом.

Решение. В силу неравенства |7(^)|2 ^ 2 (|a^(t)|2 + \j3r]{t)\2) на-

находим

M{|7(t)|2} ^ 2 (Н2М{Ш2} + |/3|2М{|^)|2}),

где М{|?(?)|2} < ос и М{|?7(?)|2} < оо, поскольку ?(?), r\(t) — гильбер-

гильбертовы процессы. Следовательно, М{|7(?)|2} < оо, что и требовалось

доказать. ¦

38 ОСНОВНЫЕ ПОНЯТИЯ ТЕОРИИ СЛУЧАЙНЫХ ПРОЦЕССОВ [ГЛ. I

2.3. Стационарные случайные процессы. Важным классом

случайных процессов являются стационарные процессы. Свойство

стационарности означает независимость некоторых характеристик се-

сечений процесса от времени. Конечно, для реальных процессов это

условие весьма ограничительно, однако оно выполняется довольно

часто, если рассматривать процесс на достаточно коротком интервале

времени, в течение которого вероятностные характеристики процесса

изменяются мало.

Определение 2.4. Случайный процесс {?(?), t G Т} называется

стационарным в узком смысле, если для любого набора t\, ..., tk Е Т

совместное распределение случайных величин ?(ti + г), ..., ?(?& + г)

одно и то же для всех т, таких, что t\ + т, ..., ?& + т G Т.

Если существует математическое ожидание такого процесса, то оно

постоянно и равно

а ковариационная функция R^{t,s) (при условии существования вто-

второго момента) зависит лишь от разности (t — s).

Определение 2.5. Случайный процесс {?(?), t G Т} называется

стационарным в широком смысле, если для любых t,s G Т, таких, что

t-seT

М{ф)} = const, cov{?(?), f (s)} = C(t - s).

Примером стационарного в широком смысле процесса является

рассмотренный выше центрированный процесс из примера 2.6, кова-

ковариационная функция которого равна Del0J^t~s'.

Пример 2.8. Пусть задан гауссовский процесс {?(?), t G Т} с по-

постоянным математическим ожиданием М{?(?)} = т и ковариацион-

ковариационной функцией R^(t, s) = C(t — s). Показать, что этот процесс является

стационарным в узком смысле.

Р е ш е н и е. Характеристическая функция ^-мерного распределе-

распределения процесса ?(t) для ti, ..., tk G Т имеет вид

и не изменяется при замене всех ^на^ + г, 1 = 1, ...,&. Следова-

Следовательно, и сами /с-мерные распределения не изменяются при замене

всех t} на tl + т, причем это верно при всех к ^ 1 и любых т, таких,

что Ьг + т еТ. Ш

Пример 2.9. Пусть {w(t), t ^ 0} — процесс броуновского дви-

движения и т > 0. Показать, что процесс Z(t) = w(t -\- т) — w(t), t ^ 0,

является стационарным, и найти его ковариационную функцию.

§ 2] ОСНОВНЫЕ КЛАССЫ СЛУЧАЙНЫХ ПРОЦЕССОВ 39

Решение. Определим моментные характеристики процесса Z(t).

Поскольку M{w(t)} = M{w(t + r)} = 0, то M{Z(t)} = 0 и

Rz(t, s) = cov{Z(t), Z(s)} = M{(w(t + r) - w(t))(w(s + r) - w(s))}

= min (t + r, s + t) — min (t, s + r) — min (t + r, s) + min (t, s) =

r — \t — s\ при |t — s ^

О при |? — s

> T.

Таким образом, Rz(t,s) = C(t — s), что и доказывает стационар-

стационарность процесса Z(t). ¦

Непосредственно из свойств ковариационной функции гильбер-

гильбертова процесса (см. теорему 2.1) вытекают следующие свойства

ковариационной функции стационарного в широком смысле процесса.

Теорема 2.5. Пусть C(t) — ковариационная функция некоторо-

некоторого стационарного в широком смысле процесса, заданного на Т, тогда

она обладает следующими свойствами:

2) C(i) = C(-i) для всех t G Т;

3) \C(i)\ ^ С@) для всех t G Т;

4) |C(ti)-C(t2)|2 ^ 2C@)[C@)-ReC(*i - t2)] для всех t^ e T.

Свойства стационарных случайных последовательностей и случай-

случайных функций подробно рассматриваются в гл. II и III. Там же будут

введены спектральные характеристики стационарных процессов, ко-

которые являются удобной альтернативой рассмотренным моментным

характеристикам и широко используются для решения разнообразных

прикладных задач.

2.4. Марковские процессы. Марковские случайные процессы

обладают важным свойством независимости будущего поведения от

всего прошлого. Это свойство называется отсутствием последей-

последействия. Иначе говоря, если рассматривать текущее состояние процесса

?(?) в момент времени t G Т как «настоящее», совокупность всех

возможных состояний {C(sM s < t} как «прошлое», а совокупность

возможных состояний {?(гх), и > ?} как «будущее», то для марковско-

марковского процесса при фиксированном «настоящем» «будущее» не зависит

от «прошлого». При этом семейство распределений процесса для и > t

зависит лишь от состояния процесса в момент времени t.

Определение 2.6. Вещественный случайный процесс {?(?),

t G Т} называется марковским процессом или процессом Маркова, ес-

если для любых tL G T: t\ < ... < tk-i < tjt, / = 1, ..., /с, произвольного

целого к > 1 и любого борелевского множества В G Б(М}) выполнено

40 ОСНОВНЫЕ ПОНЯТИЯ ТЕОРИИ СЛУЧАЙНЫХ ПРОЦЕССОВ [ГЛ. I

равенство

№-1)} (Р-п.н.). B.7)

Свойство B.7) называется марковским свойством.

Замечание. В соотношении B.7) условные вероятности опреде-

определяются относительно а-алгебры, порожденной случайными величи-

величинами {?(?1), . ..,?(?fc_i)} (в левой части) и сг-алгебры, порожденной

только ^(t^_i) (в правой части). Соотношение B.7) можно записать

также в виде

ф1)=х1, ...,t(tk-i) = Xk-i} =

где xl Е М1 — произвольное допустимое значение случайной величины

фг),1 = 1, ...,/с.

Таким образом, вероятностное распределение состояния процесса

в момент времени tk зависит лишь от того, в каком состоянии нахо-

находился процесс в ближайшем прошлом, т. е. при t = ?&-ъ но не зависит

от его состояний, предшествующих моменту времени ?&-1- Можно

показать (см. задачу 10), что для марковского процесса при любых

ВЪВ2 е BCR1) и s ^u^t

е в, | ?(и)} Р{ф) е в2 | ?(и)} (Р-п.н.). B.8)

Определение 2.7. Переходная вероятность марковского про-

процесса определяется как

при t > s, х € К1, В G ^(R1) и удовлетворяет соотношению

P(s,x,t,B)= | P(s,x,u,dy)P(u,y,t,B),

которое выполняется для всех s,u,t G T: s ^ и ^ t и называется урав-

уравнением Колмогорова- Чепмена.

Определение 2.8. Марковский процесс называется однород-

однородным, если

Р{ф) е В | f(s) = x} = P@,x,t-s,B).

Далее для краткости будем писать Р@,ж,т, В) = Р(ж,т, 5).

§ 2] ОСНОВНЫЕ КЛАССЫ СЛУЧАЙНЫХ ПРОЦЕССОВ 41

Для однородного марковского процесса уравнение Колмогорова—

Чепмена упрощается:

РО, s + t, В) = | Р(ж, 5, dy) РB/, ?, Б),

где s, ?, s + ? Е Т.

Для определения конечномерных распределений марковского про-

процесса достаточно знать его переходную вероятность и одномерное

распределение в некоторый начальный момент времени, поскольку

с использованием формулы полной вероятности и марковского свой-

свойства легко получается соотношение

P(tfc_i,xfc_i,ffc,dxfc), B.9)

где O = to<*i <•••<**, Bb-.^eBfl1), a ir(B) = P{?@) G B].

Если переходная вероятность и начальное распределение вероят-

вероятностей процесса ?(?) имеют плотности, т.е. существуют p(s,a?,?,y),

р^(ж; 0), такие, что для всех В G 1

P(s, ж, t, Б) = Jp(s, ж, t, у) с?у, тг(Б) = [р^(ж0; 0) dx0,

в в

то и любое распределение /с-го порядка также имеет плотность:

к

Ri *=i

B.10)

Функция p(s, ж, t, у) называется переходной плотностью распределе-

распределения марковского процесса и при всех s,? G Тиж,у G М1 удовлетворяет

соотношениям:

1) p(s, ж,?,?/) ^ 0 (условие неотрицательности);

2) p(s,x,t,y) dy = 1 (условие нормировки).

Приведем некоторые примеры марковских процессов.

Пример 2.10. Рассмотрим последовательность бросаний симмет-

симметричной игральной кости. Пусть случайная величина Хп есть число

очков, выпавшее на грани при n-м бросании, п=1,2, ... Введем

последовательность случайных величин по правилу

42 ОСНОВНЫЕ ПОНЯТИЯ ТЕОРИИ СЛУЧАЙНЫХ ПРОЦЕССОВ [ГЛ. I

Показать, что последовательность ?(п) — марковская, и определить

для нее переходную вероятность.

Решение. Пусть при некотором п ^ 1, ?(п) = i, где i — целое

число от 1 до 6. При последующих бросаниях значение ? не может

уменьшиться, поэтому для j = 1, ..., 6

{О при j < г,

г/6 при j = i,

1/6 при j > г.

В силу независимости результатов бросаний условная вероятность

перехода зависит лишь от ?(п) = г и не зависит от последовательности

предыдущих значений ?. Итак, в данном случае последовательность

является марковской, а переходная вероятность (за один шаг) опи-

описывается матрицей Р, элементы которой равны Рц = Р{?(п + 1) =

= 3 \?(n) = ihhj = h ...,6. ¦

Замечание. Случайная последовательность, описанная в приме-

примере 2.10, относится к классу дискретных цепей Маркова с конечным

множеством состояний. Более подробно этот класс последователь-

последовательностей изучается в гл. П.

Процесс, о котором пойдет речь в следующем примере, относится

к классу марковских случайных функций.

Пример 2.11. Показать, что процесс броуновского движения —

марковский, и найти его переходную вероятность.

Решение. В примере 2.5 мы нашли плотность конечномерного

распределения процесса броуновского движения. Для вычисления

плотности условного распределения воспользуемся формулой B.4)

с учетом того, что t\ < ... < tk-i < t^'-

(?i) = хъ ...^(tk-i) = xk-i) =

г=1

1

Таким образом, процесс броуновского движ:ения — марковский, а его

переходная вероятность P(s,:c,?, •) при фиксированных х G M1, s < t

представляет собой гауссовское распределение ЛГ(х; t — s). Ш

§ 2] ОСНОВНЫЕ КЛАССЫ СЛУЧАЙНЫХ ПРОЦЕССОВ 43

В следующем примере мы получим условие того, что гауссовский

процесс является марковским.

Пример 2.12. Рассматривается центрированный гауссовский