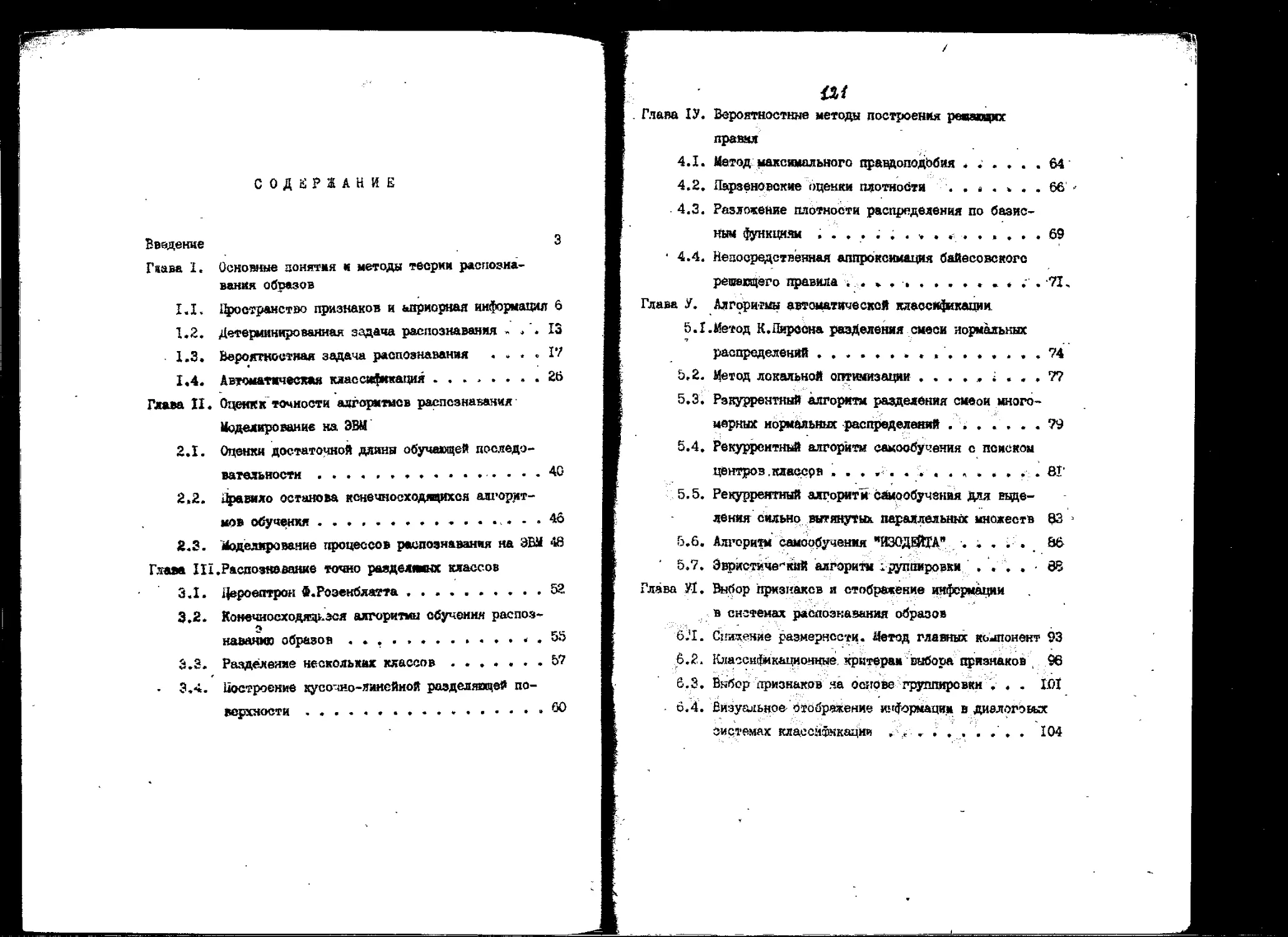

Автор: Лиховидов В.Н.

Теги: математика естественные науки физика математическая физика кибернетика издательство владивосток

Год: 1983

Текст

УДК 506 + 5X0

Печатается по решению

редазцаонно-издательского

совета ДВГУ

Рецензента:

доктор фивико-математическак паук

профессор В.Н.Фокин (.ЛГУ); навдида? фиэико-ма-

тена*ичесних наук доцент В.В.Ццин (ДВГУ)

Л55 Лиховидов В.Н. Практической курс распознавания образов.' ~

Владивосток. Издательство Дальневосточного университета,

1963. - 124 чг,

■ В учебном пособии рассматриваются ооновные вопросы теории

распознавания обраяов: сходимость алгоритмов,обучения и

самообучения, методы отбора признаков, оценки точности алгоритиюв и

метода моделирования процеосов раопознавання на ЭВМ. Изложенная

теория применяется к практическому изучении с пршененяем ЭВМ

девятнадцати конкретных алгоритмов распознавания и отбсра

признаков. Учебное пособие предназначено для студентов, обучапцихзя

во специальности "Прикладная мауематика" 0647.

Г7.2. » 35 ББК22Л2

160 - 83 бвз объяьлениг Л65

(Q) Издательство Дальневосточного J

университета, 1963

ВВЕДЕНИЕ

Теория распознавания образов- является одним из важнейших

разделов современной кибернетики как в теоретическом, так и в

прикладном ллане. В последние годы методы теории распознавания

образов успешно применялись в медицинской

диагностике,"геологоразведке, прогнозировании погоды, для построения читающих

автоматов, контроля качества изделий и т.д. Это делает их

полезнейшим инструментом в научных исследованиях и в ряде областей

практической деятельности. Владение методами распознавания образов

необходимо каждому специалисту по прикладной математике,

занимающемуся обработкой результатов экспериментов.

Сформулируем задачу раегсо^авания, (вторая иоследуется в

данном учебном пособии. Пусть имеется небколько классов объек-'

тов. Каждый объект характеризуется значениями нескольких его

параметров - признаков. В результате некоторого эксперимента

можно получить наборы (векторы) признаков для

последовательности объектов, при этом известно, из какого класса взят каждый

объект. Затем'появляется новый объект с его опиоанием, но

неизвестно, какому классу он принадлежит. Необходимо на ооноее

полученной ранее информации вынести решение о принадлежности

этого объекта.

Так как объекты изображаются векторами в многомерной

пространстве (пространстве признаков), то мы приходим-к

геометрической формулировке задачи распознавания: необходимо построить

поверхность, которая разделяет множества, соответствующие в

пространстве признаков различном классам объектов. "Если

множества в пространстве признаков, описывающие разные классы, не

пересекаются, то возможно точное разделение классов; если же

они пересекаются,., то любое решающее правило .неизбежно будет

ошибаться* поатому необходимо искать правило классификации,

доставляющее, минимум шибок*.. ^

Инфармация-г которой' обладает исоледователь до эксперимента" ,

- априорная; информация - служит для выбора конкретного типа ал- *

горитма gacnosHasaHKHv УЫ информация» которую получают в

результате укопвриаеназ& isemw$& признаков и указания о принадлезнос-

ти объектов-. 'шгагванХ яезавает-ся обучающей выборкой и служит

для построения? нашфчаеяа' правила классификации. Сам процесс

построения ззхшо правила^ т есть обучение распознающей системы.

Возможна и такая- ситуация,» когда указания о принадлежности

объектов обучающей, выборки-! отсутетвуйТг в этом случае мы инеем дело с

вадачей самообучения^

Учебное пособие написано на оемове лекций- и лабораторных

работ, проводимых на математическом и физической факультетах

Дальневосточного гооуниверситета. Основная цель, преследуемая в

этом курсе - обучить студентов грамотному решению задач

классификации, которое включает н-оебя выбор алгоритма распознавания,

наиболее подходящего для конкретной задачи, теоретическое*его

обоонование, написание и отладку программы для ЭВМ с змлиричес-

ким исследованием свойств алгоритма на модельном материале. В

соответствии с этим учебное пособие разделяется на две части -

теоретическую и практическую.

Теоретическая часть ^главк I, II я Приложение; содерйсит

формулировку основных понятие теории распознай»» о >а"ос и

обоснование методов построения алгоритмов класс! v .а ии ате-

матически задача распознавания формулируется its,/ по >ое.ние раэ-

делямце.; поверхнооти, доставляете:-: ызиЕ-'.ум некс^ *у /ь пио-

иалу среднего риска. Рассмотрены три типа задач *лс о fa a*, p

5

детерминированная и вероятностная задачи и самообучение.

Основное внимание уделяется построению рекуррентных алгоритмов обу- "

чения и самообучения. Здесь же изложены вопросы оценивания точ- "

ности алгоритмов обучения, досги;-£ймой на обучающих выборках

конечной длины, а также элементы иетода Монте-Карло, необходимые

для моделирования обучающих выборок при иоделировании

алгоритмов распознавания на ЭВМ. В приложении рассматриваются

некоторые вопросы метода стохастической алпрокоимации, лежащего в

основе рекуррентных алгоритмов обучения.

Вторую часть ооставляют главы III - У1, каждый параграф в

которых посвящен подробному исследованию -одного конкретного

алгоритма обучения, самообучения или отборагфризнаков. Фактичеони

отдельный параграф предотавляет собой лабораторную работу*

состоящую из1 пооледова'гельнооти заданий. Выполнение йтих заданий

оостазляет три стадии исследования; теоретическое обоснование

алгоритма, оос^тавление и отладь.у программы для ЭШ,

тестирование алгоритма на модельной материале. Предполагаетоя, что в

лабораторном практикуме используется какая-либо мини-SBM,

имеющая средства отображения информации и диалога, например, СМ-4,

"Мир-2" или "Наири-4П.

Учебное пособие может быть также попользовано в качестве

справочника по методам раопознавания. Все задания, касающиеся

конкретных алгоритмов, сформулированы так, что ответ оодержит-

ся в оамом вопросе., Для учащегося важно продемонстрировать

умение провести все доказательства. Читатель же, которого не

интересуют математичеокие тонкости, может легко с помощь»

приведенных формул составить программу, реализующую нугэнгй ему алгоритм,

ГЛАНД I. ОЯЮВШЕ ШИПИ И МШШ Я ' *

МОШЯИВШИ ОБРАЗОВ

1.1. Проотранотво призваков и априорная информив*» *'■-

Пусть имеется множество объектов fit , элементы Kortpo**-

го мы будем обозначать буквами А ,£,... (возможно о

индексами). Множеотво $- разбито наМ непереоекаэдихоя

подмножеств ft-i M

которые называются класоамя объектов. Над каждым объектом

Дбft.производится А/ измерений, результаты которых эск,(А\

... , 3£( (Д^ назнваютоя признакеми данного объекта.

Таким образом, каждый объект изображается вектором признаков

Эс(Д}- {XUW Х'"!(А)} в tf -мерном простраяот-

ве, которое называется пространством признаков.

Векторы в пространстве признаков ми будем записывать в

виде столбцов .

ос^ЧА}]

так что пространство признаков будет обйчным /V -мерным

проетранотвом R . На вход распознающей системы поступает

последовательность векторов признаков

Х|,...,зеЛ1...(Хк =ос(А^, (t.i.t)

ооответствуищх набору объектов At , ... . Д». . ••• из

(К • Последовательное ль ("l.i.i) называется обучлющеь

послед овательностью, или обучающей виборко;!.

Задача распознавания может бкть в обйеы аиле &№psym-

ровапа следующим образок: необходимо по вбучада»ей т$ар*&

7

-построить решвдее iipascac, то есть аравкдо/которое" душ

любого объекта AG ■&■ (возможно, ае оовцадавдего .ни о одним

из А*. * Л. ', А.*,) позволяло бк на оонове вектора "Х(А)

' 'указать, какому чз классов ft,.*, тллвдадлешт объект А ,

Конструктор распознающей системы может быть в различной

отецени оовздомлен о структуре клгйсйфЕЦируемо-й информагдаи,,

■■к-

Если для каадого объекта обучающей выборки известно, к кежо-

■ му иласеу он относится, то мн имеем задачу обучения '.$£.&-

поавазанию образов» при этом указания о прщаддзжностЕ

объектов обучещей выборки называя-гея указаниями учителя. Золи .

указания учителя отсутотвуют. то мы пряходчм к задаче оемо-

. р0учвн?я - система додьша -обучаться уздедиФь обвекты сема»

без нодокаэки со сторонн* Далее, зуотьХ<тН"1».--[М)есть

образ класоа 0Ц при отоораке1фи.;0С.(А),то"*и*^

Х = {хе I?: Зй*Х(А)# А« Cti },

■Вовможны два случая структура маояюотв {X*J, ощюдеявхвцйе

■//оноеоб решения задачи распознавания:

^а) множества ' Ai не пересекаются, б) множества &*, пере-

■еехаются.

Е первом случае возможно точное разделение множеств At*

а следовавлшо» и точное решегхе задача распознавания,

которая в stom случае называется детермшшрованной, Примеры

ситуаций б)г Еетрудяо~ж>отрой*ь ^ ^~р- Поскольку в этом случае

лмеиюд точки ОС , одновременно принадлежащие нескольким

множеотвам л£ „ то ясно,' что точное решение задачи р£су-.зА

; навашЕЯ вдесь невоамсияр, т-»в» для аекоторкк объектов на оа~-

'vHobs нх векторов признаков лрин!щшй&льяо невозможо одаоэчач-

яо установить хгринадлзжнооть к току или иному классу* Додоб-

»••***"' ""£&■ ■* "?"''

ные оитуации ш условились трактовать в вероятностном омнолв!

мы будем считать, что векторы признаков, соответствующие

объектам хлаооа &i , являются случайными величинами и

распределены в соответствии о некоторым распределением

вероятностей (своим для каждого класоа).Тогда случай Х;,ЛХц^0

еотеотвенно отмывается в терминах перекрываацкхся шютвоо-

тей распределений и задача раопознаваюш носит название ве-

роятжотяой.

Теперь мы еще более детализируем постановку задачи,

рассматривая отдельно три случая,

I.I.I. Детерминированная задача раолозыавания,

рш простоты будем пока предполагать,что имеется только

два класса &«.', Лг , и пусть Xi Л Хг = 0 .Тогда?

существует разделяющая функция,т.е. такая функция |* С^-) ,что

. *о даже)!,

•. *v для »е Хг

Для того чтобы обучать машину узнавании объектов клаВсов ft-i,

О-г нам в дапком ожучаэ достаточно построить фуягадо if Ок),

знак которой оозпадал бы оо знаком t^ia<ium |»Сзс):

f(uc)sO если f.fatjjo,

j(X.)<0 если |»(жНО,

или ;:наче можно эвжоать

$(ъ)1*Сх.)>0 Vx&XinX2.

Яриг.:гош оиотемн, решающей дьтер:,п:ы;ро^шую .3^чу распозна-

ваш'а,является персептроп Розенс'латто (с:.,. J 3.X.).

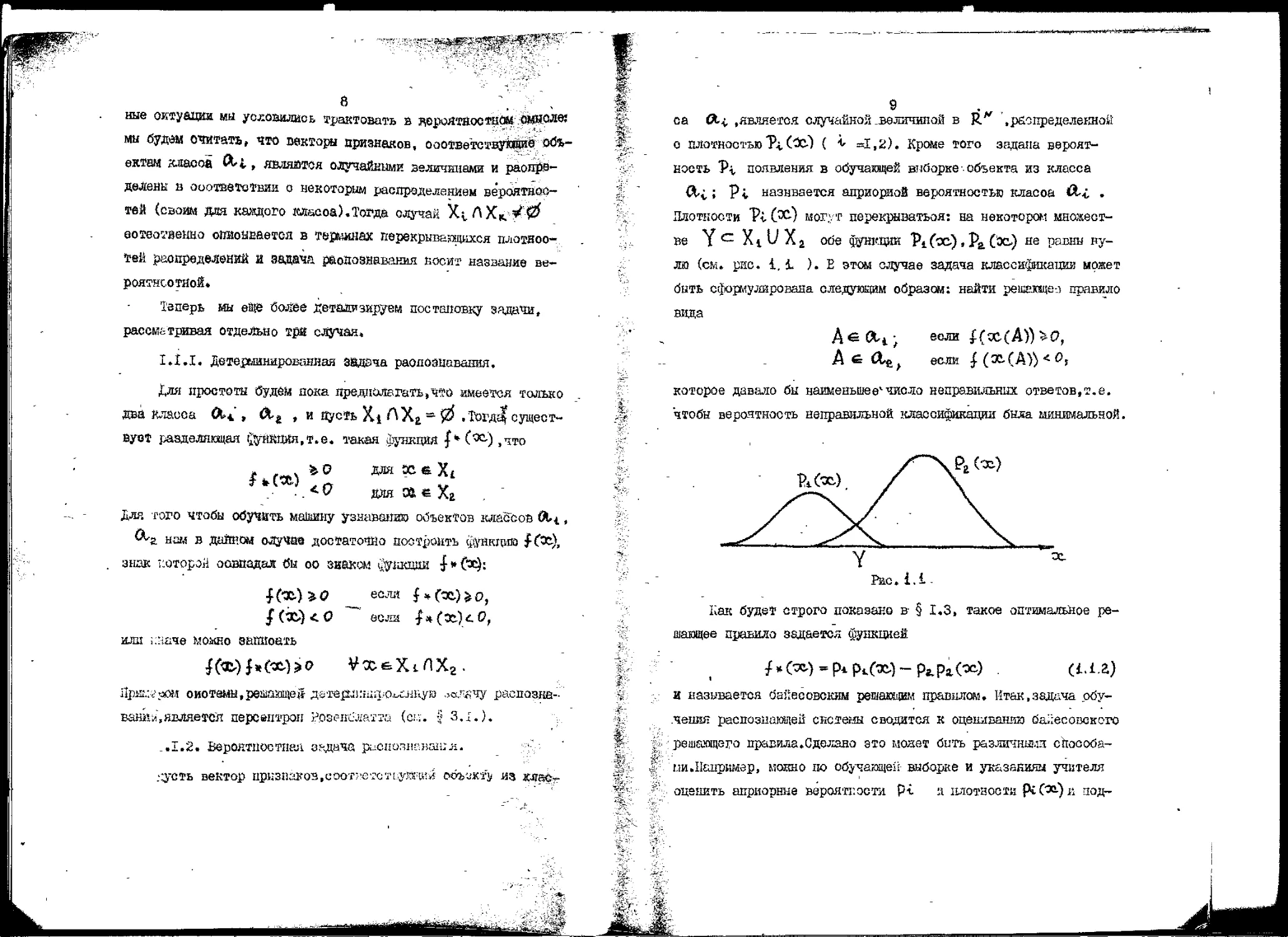

_.1.2. Бероятпостная оэдвча р;-1Снопнг.нашл.

:;усть вектор прпзп^оз.иоотретстЕ.уяни^ o&bwf}/ из деласг

са #..(, .является случайной .величиной в R" ",распределенной

о плотностью 1\ (*0 ( *■ аХ,2). Кроме того задана

вероятность Vi появления в обучающей шзборке объекта из класса

&v • Vl назнвается априорной вероятностью класоа <&i .

Плотности Vl C^w могут перекрыватьоя: на некотором

множестве Y с X1 " л 2 обе функции Vi fac) • V% (Эь) не равны

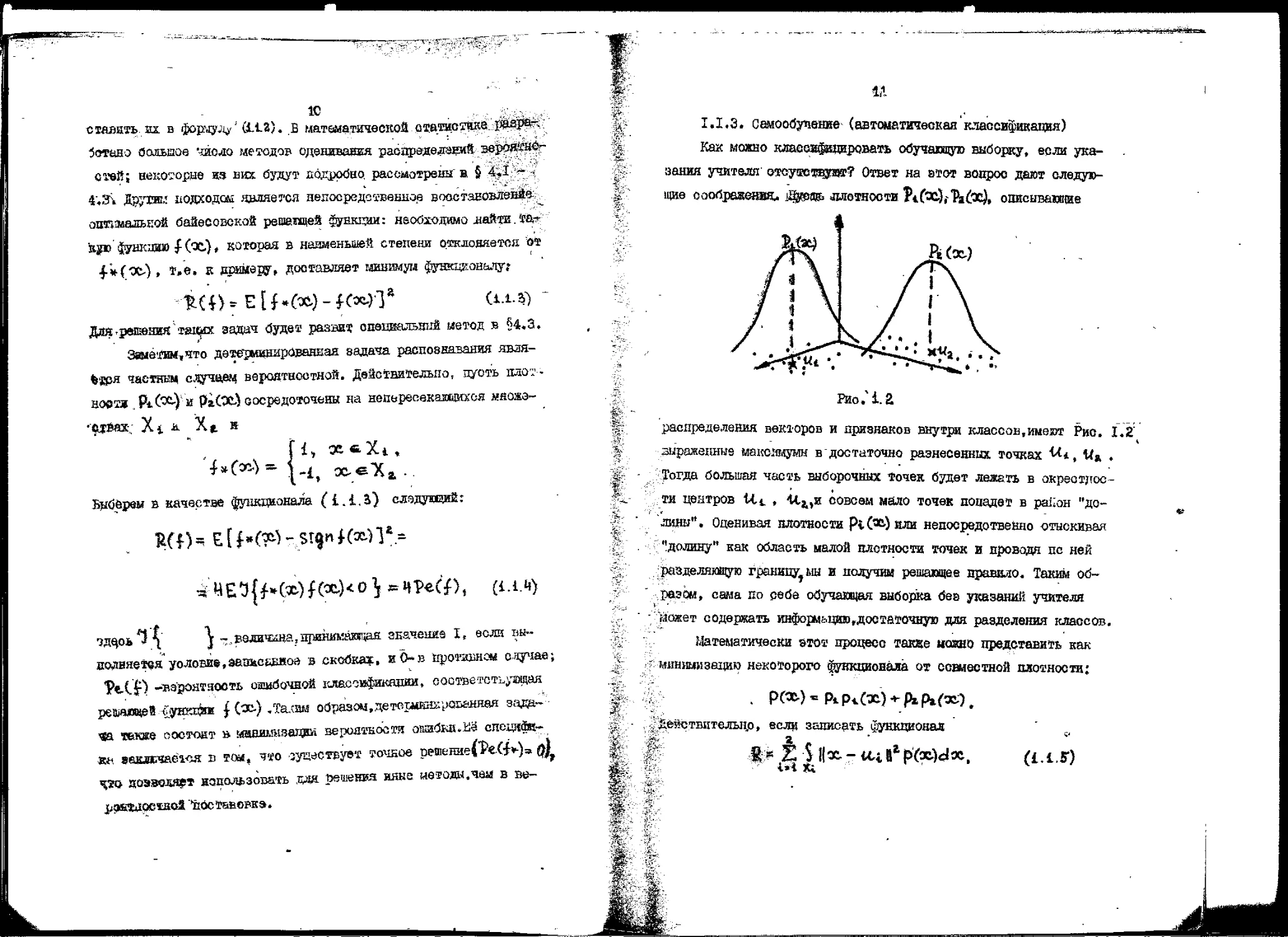

нулю (см. рис. i. 1 ). Е этом случае задача классификации может

быть сформулирована следующим образом: найти решагсще-л правило

вида

ДеСЦ; если £(;с(А))»!?,

AsOj) если J (X (А)) < О,

которое давало бы наименьшее1 число неправильных ответов,т.е.

чтобы вероятность неправильной классификации была минимальной,

Рис. 1.1

Как будет строго показано в- § 1.3, такое оптимальное

решающее правило задается функцией

/„О^р^х^-р^о) . (i.i.a)

и называется байесовским решающим правилом. Итак,задача

обучения распознающей системы сводится к оцениванию байесовского

решающего правила. С делано это модет бить разлЕгтшд ейособа-

пи.Ыанршзр, глокно по обучающей выборке и указавши* учителя

оценить априорные вероятности Р-С и плотности рсСэ^) л под-

1С

стлать ш. в формул/ С1Л.г). в математической статисдае

разработано больше '-гасло методов одещшашя раолредедэниИ эероййи^

стей; веко"орве та них будут подрооно рассмотрены в 5 4,1 -

i'.Sv Другак подходом является недоередствеыие вооемижлевЛе

оппмааькой байесовской решащей функции: необходимо яайти та-*

itjfo функ:ад) £ (х)» которая в наименьшей степени отклоняется от

4-~*(/Х-) , т.е. к примеру, доставляет мншшум функционалу}

Для .реюния" таких задач оудет развит ошпиальзия иетод в §4.3.

Здаетнм^что детерминированная 8адача распознавания явля-

%'рря частнви случаем вероятностной. Действительно, пуоть адот-

аоетя PiC^n РгСЭС} сосредоточены на непереоекаииихоя множэ-

•$твах-, Xi a X* к

ft, «*Х4,

Выборе» в качестве функционала (i.i.i) слодушщй:

Tift) - Е [ h№ - Щ» № У .=

* ЧЕЗ{М*-Ш*-)<0^ =4P€Cf), (i.i.l)

■эдцоь^ \ I ~.,воличеда?принш£аю1т;ак значение I, если вы-

иодияетвя уоловие.эазксшной в скобка?:, и О*в противнем случае;

*PtCf) -вэронтзооть ошибочнее клесглфшяюо!, еоответотьулнтдя

решающей <7уикп?т £ С*-) -Та.<шл образом,дето!иин£рдаанявя зада- ■

■«а текже ооетокт в мавишдаяий вероятности ошибки.iia спецяйн-

ж*. ваклЕчаёкуг в тоа, что -зук»сгаует точное решениеСРеХ!*-)» $у

4SQ зоэзводяарт использовать ,тда решения ияне метода,чем в ве-

jUpSC&IOCIHOt ''ПОСТШОВКЭ.

11

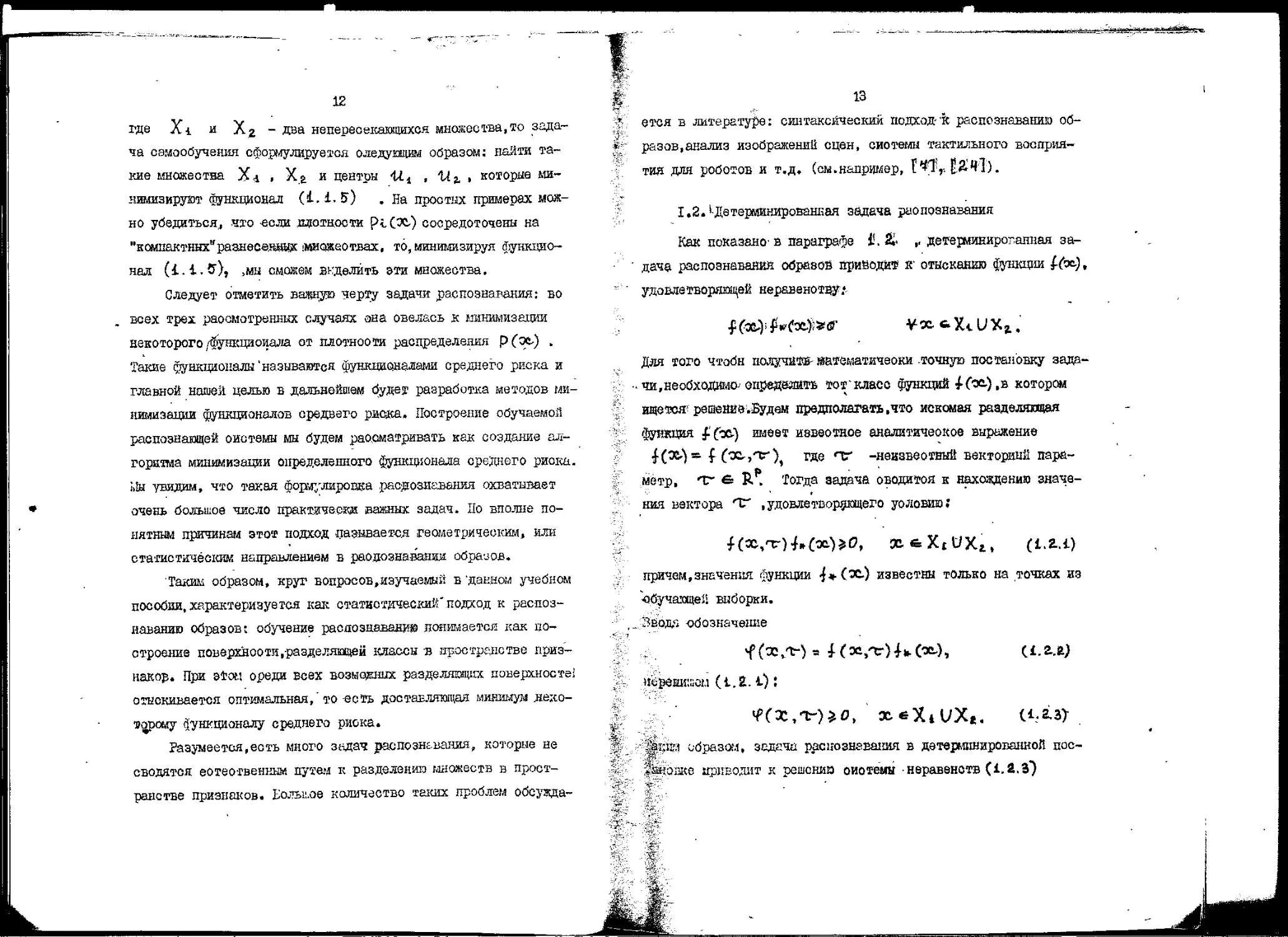

1.1,3. Самообучение' (автоматическая классификация)

Как можно клаесафщэфоваздь обучающую выборку, если

указания учителя отсузетвзгая?? Ответ на этот вопрос дают

следующие соображения* $$$>№ ллотности ftfx^l^x), описывающие

Рио.Ч.а

распределения векторов и признаков внутри классов.имеют Рис. 1.2"

зараженные максимумы в достаточно разнесенных точках ^i, M% *

Тогда большая часть выборочных точек будет лежать в

окрестности центров lit . 'М^и совсем мало точек попадет в район "до-

лини". Ояенивая плотности р«.ЗД или непосредственно отыскиээая

'!долину" как область малой плотности точек и проводя не ней

разделяющую границу, ш и получки решающее правило. Таким об-

разом, сама по себе обучающая выборка бег указаний учителя

гложет содержать информытию,достаточную для разделения классов.

Математически атот процесс также можно представить как

минимизацию некоторого ^вкционала от совместной плотности;

действительно, если записать функционал S1

f * Z SHoc-ail^Wdx, (i.t.F)

12

где Xi и Хг - Два непересекающихся множества, то

задача самообучения сформулируемся следующим образом: найти та-

кие множества X* . Х& и центры 411 , У.г , которые

минимизируют функционал (£. i. 5*) . На простых примерах

можно убедиться,, что -если сложности Pi-C^) сосредоточены на

"комшктннх"разнес©,}ще!: 'Множествах, то, минимизируя

функционал (i.i.ff), >мы сможем акделйть эти множества.

Следует отметить важную черту задачи распознавания: во

всех трех рассмотренных случаях она свелась к минимизации

некоторого /функционала от плотнооти распределения Р(э&) .

Такие функционалы'называются функционалами среднего риска и

главной нашей, целью в дальнейшем будет разработка методов

минимизации функционалов средвего рис&а. Построение обучаемой

распознающей системы мы будем рассматривать как создание

алгоритма минимизации определенного функционала среднего риска.

Цы увидим, что такая формулировка распознавания охватывает

очень большое число практически важных задач. До вполне

понятным причинам этот подход лазиваетсд геометрическим, или

статистическим направлением в распознавании обра-зов.

Таким образом, круг вопросов,изучаемый в 'данном учебном

пособии, характеризуется как статистический*подход к

распознаванию образов; обучение распознаваний понимается как

построение поверхности,-разделяющей классы в пространстве

признаков. При этом ореди всех возможных разделяющих поверхносте!

отыскивается оптимальная,' то -есть доставляющая минимум дедо-

т-орому функционалу среднего риска.

Разумеется,есть много задач распознавания, которые не

сводятся еотеотвенкым путем к разделении множеств в

пространстве признаков. Еольи-ое количество таких проблем обсужда-

13

ется в литературе: синтаксический подход-'к распознаванию

образов,анализ изображений сцен, сиотемы тактильного

восприятия для роботов и т.д. (см.например, Г"#Т> £.£Ч]).

I «2.*-Детерминированная задача распознавания

Как показано' а параграфе 1!. % ,. детерминирог-апная

задача распознавания образов приводив к' отысканию функции l-fa),

удовлетворяющей неравенству*.

Для того чтобн подучи»- штеыатйчеоки .точную постановку

задачи, необходимо-' определить тоткласс функций 10»),в котором

ищется" решение.Будем предполагать .что искомая разделяющая

Функция £fo&) имеет известное аналитичеокое выражение

£(ЭЬ*)к f ('Xrjtr)^ где Т -неизвестный векторный

параметр, *тг 6 R . Тогда задача оводитоя к нахождению

значения вектора Т .удовлетворяющего условию;

причем,значения функции 4*(х.) известны только на точках из

"■обучающе*: выборки.

Зводь обозначение

исрешниом (1.2. i):

^x;ii'i образам, задача распознавания в детерминированной пос-

*s*iOj3Ke приводит к решении оиотемы неравенств (1.2.3*)

и

' (таких неравенств в системе (i. £.3) столько же, сколько

элементов содержит множестве Ж « Xi U Х^ ).

Сдним иэ способов решения ,такой задачи являются

рекуррентные конечно-сходящиеся ажотпш.

Определение. Рекуррентный вазшаетея алгоритм вида;

в котором каждое оледуяцее приближение к рцевдшаемому

параметру строитоя как сйункция предыдущего- приближения и вновь

поступившего "измерения" X*v .

Такие алгоритмы наиболее удобны для реализации на ЭШ,

поскольку они не требуют запоминания всей обучающей выборки

Xt,... ,31ч,.Это имеет особенно важное значение при решении

задач распознавания на мини- и микро-ЭВМ, объем оперативной

памяти которых ограничен, В дальнейшем мы будем всегда

отрекаться к построению именно рекуррентных алгоритмов

распознавания.

В частноотн, для решения систем неравенотв (i.Z.i)

применяются рекуррентные алгоритмы следэпощего вида

т., i - т.. г А. й~ V* Ч" (*~,чг-), (i.a- -О

где

, _ ! I, если M'CX^.t-^iO,

"" (. О , еоли f (I», f«.) > 0,

ГЛ^У-некоторая неотрицательная чиоловая последовательность.

Алгоритм (1.2..Ц*) имеет естественный вид: ьектор'Vh.

сдвигается в направлении возраотшшя функции ^(*,'"*г)р если на и^м

шаге не выполняется неравенство (LiL-i-) ; в противной случае

Т"*. остается яа меоте.Последовательность (&«,^додяна быть

15

выбрела так, чтобы обеопечить сходимость'алгоритма (I.Z.4)

за конечное число шагов.

"^Драделение.АлгсшиГ^- Ь. Н) называете»

конечно-сходящимся,если для лвбой обучаицей выборки ^3tt,.,.,»»,, ._. \ ж лю-.

бото начального вектора Тг е К. найдется таков номер X ,

что ^(ос^.тяЧ > О для всех и- » fit .Очевидно,нечжьая с этого

вомера к. , вектор "Тк перестанет изменяться! ft, •= ^л **.

Покаяем.что в алгоритме (t.ff. Ч") при некоторых условиях

можно так выбрать последовательность ^&*.},что он будет" ко-*

вэчво-сходящичоя.

Теорема T.I.. Йуоть внтголяеян сладупцие уолсвия:

где 0-1, С j, не зависят от X ;

-2}сзтаэетнуют вектор тг» е. I* и число в» >0 такие, что

4>(-х.,тг»')>*».,' ос е X ',

3)справедливо неравенство.8

- Выберем числа 0.и,Е алгоритке (1.8.4) :

где А*.ё [О, £1, X» -число изменений- вектора. TV за И«

шатюв алгоритма,'Ci B i,

(ОС к.'. , если > (Ж .., О-.0 >0,

1*м*,аодя f(X^,tw)40.'

Тогг<а алгоритм (1.2.41 будет конечно-сходящимся.

"ГДоказательство: Лредполояим.что на И- -м шаге произошло

исправление вектора f*. .тогда соглг.спо (1.2..У) z (i.Z.s)

-Г

16

"i! Тк-т» 11г+ гг?ла„. (t*. - %, ^ f (х л>тг^) +

4 II т*-о; 11г+ 2-Л. аЛч^лг..) _ 4>(x».,tv)l ♦

+ iia.» llvc.'«f(otB.,'r».)ii!

a a силу условия 2) доказываемой теоремы/

flTW-TrJI'illtw-t.f-

- г Л й„ (*»=f (а^т.))<• 4 «; цуг f (хЛ, tw) Г.

Подставляя овда CL„. из (I.E. б) и rpjmmpya слагаете, по-

лучпи неравенство?

lllS,u-Tr»ll^ inr„--tvl|l- 2г1 |t +

Последнее слагаемое б правой ^нота мола;о отбросить, посколысу

ояо аецрложительно; то же самое справедливо и для третьего

"слдагеыэго (рая гролзошдо дещ явление,то *f Сх^/Х-УРЭ.Не-

ггрудар доказать,что в четверга, слагаемоз неположительно, и та-

/ик 'обрезом,

Вf«i --'с, «г * St-,-1-»f-g.t»„.-i^;

Оуилпр^д этл Ейрслелстяа .по 11. от. i до /Т ,находим;'

| 17

г. таким образом, 1|тгкм-Т^Пг6 1К*-тЛ*~ 2€* J^ 4" '

£ откуда я следует,ч^о Х.п не может стремиться к бесконечности

при Vb -* —>. Теорема доказана.

v ^та теорема позволяет обосновать большое число алгорит-

- мов распознавания в детерминированной постановке,Общая схзма

ноет:оеыия алгоритмов распознавания состоит при этом в

следующем. Пусть разделяющая поверхность ищется в_ классе функщй.

fOxrtr)*Обозначим через ©"„, указание учителя относительно Си*,,

т.е., QV = sicpi ^«(XivV

Тогда конечно-сходящиЭся алгоритмгполучаеШ2# из (±,2,ц*) ,

{i--Z 5") при замене ^(за*-,^»*.) на §~к.£(3(КЪ0 будет

алгоритмом обучения распознаванию образов:

MS:

если e^ffX^Tr^-) S 0,

если 'SW f (ЗС-л, TT„) > 0,

»' ,, Т^З. Вероятностная задача распознавания

-.' Дадим строгую математическую формулировку вероятностно:?

^ задачи распознавания.Пусть на вероятноотной пространстве XI.

задана случайная величина И .принимающая конечное число зне-

f чацвя, i_'eIi,,,,,M.\, М ^ ■£• Будил интерпретировать

> э^чеяие случайной величины Ъ как номер класса,которому дри-

Нщлежит объект.появинзийся на входе распознающей системы,

/ 5^"Да вероятность рк*р {*fs £\ есть априорная вероятность W*.

Пусть кроме того имеется векторная случайная величина \ ,

принимающая значения в пространстве признаков Rv ; значение

ОС случайной величины ^ есть вектор признаков

объекта,поступившего на вход распознающей системы. Предположим,что

существуют условные плотности распределений для каждого из классов,

то есть для множества 1ЬС Я *

Очевидно, распределение случайной величины ^ будет иметь

плотность i

м

(этот факт следует из формулы полной вероятности).

КашЕ. задача состоит в том, чтобы наилучжм образом

провести классификацию объекта, заданного лектором признаков,то есть

необходимо построить таков правило, которое по вектору

признаков указывало бы, к какому из классов&-iT - . jOL^a относится

соответствующий объект. Слов& "наилучааш образом" предполагают,

что у нас есть способ количественной оценки построенного

правила классификации,Поэтому прежде всего определим,что да будем

понимать под качеством классифицирующего провила. '

&дадии матрицу потерь С —{Cht >"k,£ ™ i-,-., -М }

элемент Сit*i, которой имеет смкол штрека [ни ei;b), связанного с-

относеыием объекта, принадлежащего К. - щ классу, в t -й ■

класс. Р£осмотрим разбиение [Xi\ (£*i, ■ ■ ■, М) пространства

У. на М. непересекагащихся подмножеств.Этому разбиению будет

соответствовать решающее правило £ :

o\3t)»i, Шла. х ^ Xi

v 19

(мы относим объект к классу (%,±геслк его вектор признаков

попадает в Xi ).Очевидно, ркРкСх) dx. есть вероятность

попадания вектора из К. -го класса в окрестность doc точки СС,

Средний риск (штраф) отнесения объектов к. -го класса в <--й

класс равен

где Ух, С"Х) -индикатор множества X с .Общий риск получится,

если это выражение просуммировать по всем г, к, X. :

_ м м

£ (?) = ) Z £ \ №)<vv р* p. № dx •, (1-3.2)

R* i=i K*i Av Г l

&(й)-средний риск соответствующий превилу классификации

о, является критерием качества* чем мейыпе к ( б J, тем

лучше правило $. С математической точки зрения Ё.(о) является

функционалом на множестве решающих правил (ок сопоставляет

численную оценку каадому решеюжему правилу о ^поэтому его

называют функционалом среднего риока.

Оптимальным мы будем Ьчнтать решающее правилоtимеющее

- наименьшее значение Ж$) .Вероятностные охемы.в которых

рассматриваются классы распределений о заданными на них

априорными вероятностями, называют в теории отатиетическях решений

байесовскими.

%■ Определение. Байесовским решающим правилон называется ре-

*L'' шающее правило минимизирующее средний риск.

С Итак, пуоть задана вероятностная схемами. ,{\(ос-) ,k»i ,

С" ... , ЬА и матрица потерь С= f^icLj • Какой вид имеет байе-

f "совское решающее правило? Для того, чтобн ответить на этот

:; допрос, преобразуем сначала &(ff) к более удобному виду. Вве-

-■ft 'i.

го

Тогда функционал среднего риска прилет следущий вид.

Ш) °& S„ \(*-) =UC3 P Wdx - (1.5.4)

Удобство такой зашей оостоит в том, чтоИ("£) здось явно

выражен как математическое ожидание некоторой ?унк1эди, а именно ;

Естественно ожадать, что $ушщдонал(1.$. й) достигает минимума

в том случае»' когда мн относимв класс X i те точки, для

которых cii (ос.) меньше любого dl*. (ос.), k* i. Для доказательства

оптимальности такого реиакщега нравмла нам понадобятся

утверждение, которое удойно офэрмэть з виде отдельной леммы, так

как око неоднократно будет использоваться в 'дальнейшем,

Леша 1.1» Йуоть разбиение |Xi , i«-i,...,Mp

определяется соотношениями;

Тогда дчя любого" другого рнзбиення j Xi, \ и Ot <£ £. справедливо

неравенство;

- Доказательство. Отметим, что s опгелолешш. (А.З.ь) никак

не учтены точки" " границу > для кото пых fy\, (сс.тг)» ^(х,^.

Поскольку мы предполагаем существо с tj ^ в i о i ости

р(сс), то границ имеет нулевую ве о mi jc и nit. и ада

в йутадаонал (1.3.iT) . Но для т го "т j г Xt

составляли в сумме вес пространств" и Р- о j J vu ть

Щ 21

Л в них и граничные точки. Условимоя для определенности считать,

что граничная точка принадлежит множеству с меньшим номером.

£, Поскольку множества ^ *^i\ не пересекаютоя и VXi e Е- ,

♦ то Z Ч%9 (ot) ^ i. V ос в £.* и аналогично £ \. С») * i

I- ¥ot e £/" f а -следовательно, при любом 1С

м

&■* Зафиксируем теперь точку X е Я * Так как она обязательно по-

^ падает в одно из множеотв \ X {[, то найдется такое к. , чаю

V* y„*(x-)»i. Добавляя левую чаоть (1.VS) к dCx^)t получим^

;_ поскольку Х«(ос-)*-0 при W К . Но в ойлу определения мно-

^ жеотва Х£ для X сХ^имеют песто нераванотва dtCot) 4сЦ(х-)

jT дрн всех tyk. Отсюда следует <АСх)&0t что в оиду произ-

~^Г вольности точки X и доказывает лемму.

">t - Теперь легко показать, что разбиение I Xi \ * определяе-

#£у*ыов соотношением (i.J.fc)i является оптимальным.

Теорема 1.2. Байесовское решающее правило 'определяется

^ ^"^ разбиением ;

Щ 41§йо|сазательство» Очевидно, разбиение (L.b.£) и (1,Ъ.9) эквива-

& "-йеатны, так как в облас™, гдерСс)=0, разделящие граннтц*

А- * а\

■^ ^ейшо проводить как угодно, при атом значение R(b; не язме-

нтся. Пусть |Xi j - произвольное разбиение, тогда согласно

Йедае i.. i I

Z2

где У» -решающее правило.соответетвунцев разбиению (1.4. $у

Теорема доказана.

Рассмотрим один очень важный чаотный случай построения

оптимального решающего правила. Пусть матрица потерь имеет

вид;

fi при К?**,

1 0 при i~ К

ft.4.10)

при I ~ К.

Тогда оптимальное. разбиение состоит иэ множеств:

= Л .{PupK^^Pipif»)},

что соответствует рекалиему правилу: 'X. относится к А*,е<ш(

ft Рг<*> ? PjcPJW даи"воех k + t fi.».u)

Дик матрица noTepbfi.i.U?) функционал к(?) есть вероятность

ошибки решающего правила.Особенно простое вид этот функционал

имеет для двух классов (М-1^):

£(8) = Pi S pi(=-W« + рД ptf3u)d« ,

Таким образом,ретагащее прашш>(±.3.и) г.пшжизирует вероятность

ошибочной классификации.

Пример .Классификация для гауссово rant распределений векторов

ПрНЗН&КОВ.

Пслболее часто лрииеняется в ш;те;^.т;:-чес::о.;: статистике

нормальное (гауссосское) расирзделокие. ^го ст^пио кар с осс-

з?

*

бой ролью,которую играет нормальное распределение в теории

вероятностей (см. центральную предельную теорему),так и с

простотой аналитических результатов.Наномним.что многомерное

нормальное распределение есть распределение е плотностью

?(х,л,к) =(^JLj^ exp [- i A'V-o-Ux-a)], <i.ws)

й- -средний вектор, А - ковариационная матрица:

К*

А= 5 (x-cO(»-ft.y,p(x.,,utA)dai.

я"

Рассмотрим случай двух кл&сеов, М *.Ш Байесовское

решающее правило удобно записать тогда лополёйуя отношение

правдоподобия р*.(Х)/Ра (эс) : X относится к классу GL± .если

*** Додотавляя сюда плотностн(Д-3.1&) .видам,что решайте правило

^ " определяется разделяющей поверхностью второго порядка:

Ра

-(A;(«--at),a^- аг)*2^г

?! '

Полезно проследить на конкретшх примерах (выбирая для N* £

достаточно простые матрицы Ai. ),какой характер имеют поверх-

, ности |(ж) = О .1Ш здесь остановимся на случае,когда обе мат-

**а5ицы Ai единичные. Разделяад&к поверхность тогда превращает-

^«я в г1шерплоскос'№:_

24

Pi

Еь-jtK априорные вероятности равны, PteP2 » *о гиперплоскость

|Гх)»0 проходи? перпендикулярно отрезку, соединяющему &£ и

*2.2, через его середину.

Итак, мы получили вид решающего правила, минимизирующего

функционал среднего риска.

Однако, при решении задачи распознавания мы не имеем

достаточно информации для использования этого правила, т.к.

могут быть неизвестны ии плотности p.(oc)^iA априорные

вероятности р. . Иначе говоря, мы долкны принимать решения, имея

неполную априорную информацию. Для преодоления ятой иеопределенг

дойти и олужит обучающая выборка. При этом возможны два пути

использования Ёмлирическнх данные: а)оценивание плотностей

распределений и б) непосредственное восстановление параметров

оптимального решаьа^еге правила. Рассмотрим в отдельности оба

этих пути.

Оценивание плотностей распределении представляет собой

классическую в&дачу, решаемую в математической статистике. А

именно, пусть имеется повторная выборка (то есть, посяедоэатель-

ность независимых одинаково рвсяределеннах случайных величин)

3Ci,...,0cWj... с плотностью распределения pfvc) . Необходимо

построить оценку функции р (*). Известно много методов решений

этой задачи, например, метод максимального правдоподобия,

байесовские методы оценивания, неп&ьамвтричес^яе оценки плотностей

Схема обучения распознаванию выглядит теперь следующим

образок. Обучазоцая выборка разбивается на подвыборки, соответст-

25

"*, вующие отдельным классам.Оцениваются плотности распределений

t дая каждого класса pi Ой и априорные вероятности классов Pi .

*- Получешше оценки подставляются в байесовское решающее пряви-

,i до (1.Ъ.11),которое и попользуется для классификации.Такой ме-

*j тод решения задачи распознавания рассмотрен в параграфах 4.1-

Ивогда предпочтительнее может быть другой путь:не оцеаи-

_/ вать плотности и, априорные вероятности,а непосредственно ис-

I?' яать параметры байесовского решающего цравила.Раесмотрим для

^ простоты разделение на два класса;введем функцию е!(эс) ,на-

-f ^зываемую степенью достоверности принадлежности точки эс. к

"V классу <Xi i

•-, Вта.фуввцня однозначно определяет байесовское решающее правя-

J?\ -X~ai, если dC-xi)?-^'

вехоторых случаях функцию dCx-) бывает восстановить проще,

>Jen оценивать в отдельности Pi,pi.PtfOtt^piCx}.

По оудеотву, dfx.) есть условная вероятность того, что

5EV

воявингойоя объект принадлежит первому классу,если его вектор

внаков равен х- (иначе говоря, d (х-) -апостериорная

вероятность принадлежности вектора Х- к классу ft. t' ).

Пусть ^и есть указание учителя,

10, если Я.».~ Я.в,

1, если •ОС». *-» 0U ,

2»1до имеем:

Z6

откуда

Доложим 5 к. ~ ^ ~*^(^i') 1 тогда мы имеем

функцию,наблюдаемую с помехой;

Предположим,чтое!{х.) можно представить в виде линейной

комбинации о, ливейно-незавиоимых фикций *?i (X) :

d №) - %;• «Pi {^)^> - (т., •? с=»,

. глв

fttt?

?(*•) =

Тогдр восстановление байесовского ре&еющег-о правила сводится

к оцениванию вектора коэф^циептов Т"» .что moj$qt быть

сделано, например,с помощью метода стоадстичес«ой'ая1фокс>ша,***к

(ом. § 4,4,).

1.4. Автоматическая классификация.

Для успешного решения задачи самообучения необходило,как

это вытекает из рассуждении пункта 3' § I.I, чтобы в

пространстве признаков 6з*ществозаяй четко выраженные "компактные"

груша»* *еочек .Математичеоки строгая формализация задачи само-

о6ученкя',с-'*вдовательно1да5*-ща опираться на понятие близости

I

-v

27

векторов признаков и расстояния между группами векторов. Мы

рассмотрим три таких формулировки,позволяющих единообразно

охватить большое число алгоритмов автоматической

классификация. "

I.4.I. Кластерный авЕлиз

Рассмотрим обучающую выборку конечной, длины oct,..,, эс.

Пусть{Xi^'mXi,...,)^!- раэбизние этой выборки на М

непересекающихся додмножеств.Введам некоторую функпию d(X,ty) ,

характеризующую степень различия {шш наоборот,схдпства)

объектов, описываемых векторами признаков Ой и <£■ .0 помощью

зтсй функции можно построить критерий .характеризующий

качество разбиения {XU .Тогда задача самообучения будет состоять

в отыскания разбиения обучающей выборки,которое обладает

наибольшим качеством.

В такой формулировке самообучение называется также

группировкой или кластерным анализом.Очевидно.результат

группировки оуадэственно зависит от выбора мери сходотва-различия -

■ векторов и критерия качества группировки.Рассмотрим

несколько ирщеров:

Евклидово расстояние —

ds(x, V - 8* - ^ .(Z (Ж-"*- f*f)v'

равномерная метрика —

меттжка.п*зост13анства ***

раостошше Надалонобиоа определяется гаадратичной формой

£де % -выборочная ковариационная матрица:

}1Ч,г\1Л

28

мера Ддефриса-.'^атуси'гы -

rw(x, «*)=< X(VtetMi- УП^)г)^

ко&ф^щент дивергенции

Все перечисленные функции являются мерами различия (tiCx,^)

тем больше,чем сильнее X отличается от Ч- ),хотя

расстояниями в строгом смысле являются только три первые из

них.Рассмотрим также два Примера мер сходства:

коэффициент корреляции —-

"потенциальная функция" —

Для построения критериев качества группировки введем

понятие рассеяния внутри множества Xi;

2

Ш$ -

ШОч-i) J; |r-***xt dCxJ •

( H4-число точек обучающей выборки,попавших в Х{ ) и

расстояния между множествами Xi , Xj :

!еличш мсйено построй;

•шщровкн, н'априме р J

мгрупповой разброс -

Хк.ех1 эсе'« -

С помощью этих величин мссшо построить разнообразные

критерии качества группировки,напримерJ

рредниЗ внутригрупповой разброс

_средняя удаленность групп -

Можно оргвнйзоветь также различные комбинации этих покаэате-

V

1ь Ч ,■ W

метим,что eMmd("X,^}-«epa различия,» 9i подлежит миними-

| задай (разбиение |Х1|тем лучше,чем меньше Ч4 ),а ^г -мак-

;■ Химизации, воли scedC^c,^.)-мера сходства,то наоборот. .

I. 4.2. Разделение смеси распределений

Ооратшся опять к статистической формулировке задачи

лоиу>икащщ.Предположим,что векторы признаков объектов

-го класса имеют плотность распределения p-i№, V ) ,где

j V -яеизвеояыи параметр; и пусть Р ' -вероятность появле-

: в обучаицей выборке объекта из «• -го класса (априорная

ятнооть i -го класса) .Тоста в целом обучающая выборка

Рудет реализацией последовательности случайных величин,име- '

. плотность распределения

ксящую от набора параметров,

f-{ptl\-'..,ptMW">.--->'",'V.

Задача оамообучеюш заключается здесь в оценивании век-

< параметров 't" по обучающей выборке.Распределение с

ргаостыо вида (i.«.*•)называется смесью распределений,отсюда

'" Название подхода - разделение смеси распределений.После

'р как параметры \р , $"*}оцененн, классификация объекта

с -зектороп признаков эс = ЗС-(А) может быть произведена,

пример, с логлощью байесовского решающего ирмталги (i 3.1 if . ^

30

Итак,необходимо оценить-неизввстний параметре

плотности распределения pps ГС") .В математической статистике

разработано несколько методов решения §той задачи.Наиболее

распространенным является метод максимального правдоподобия,в котором

за оценку тг принимается значение вектора т*

,максимизирующее функцию правдоподобия \Е1 ^рф^р^.Мы воспользуемся

рекуррентным вариантом метода максимального правдоподобия. -

Обозначим Т-^ истинное значение.неизвестного параметра

тг и покажем, что т^. доставляет максимум функции

.Согласно известному в теории вероятностей

неравенству Йенсена [12.1, для неотрицательной случайной

величины ^

Отсюда имеем,

= Е^рЛгт^ 4 -^ Б рсг^д -

что н требовалось.

Вели рСэс/ъ) дифференцируема по Тг ,тоТ* удовлетворяет

уразценщ) %

Непосредственно найти f отскща невозможно,так как в зто

уравнение входит неизвестная плотность распределения,Можно,

однако .воспользоваться методом стохастической аш/роксаатацпи.

Применяя для рев?еьия уравнения (£.^2) алгоритм Роббпнса-ЭДон-

ро.получаем рекуррентной алгоритм нахождения оцоики максималь-

hoi-o правдоподобия:

ТиМ - т* - у„ Vt'£H,p{au«.>lX).

Подставляя сюда конкретный вид плотности (1.4.£.) и параметра

Пг .получаем рекуррентный алгоритм самообучения;

РСК~,Т-~) (1ЛЧ-)

i - I fftV.

(здесь учтено условие 21рн+А~ i).

Условия сходимости алгоритма Роббинса-Монро (теоремаЩ)

г*м данном случае на выполняются. В частности,уравнение(1.М.г)

"дай функций pC3e.>*tr) вида (i.4. t) имеет не единственное

решение (действительно,если ^~ -решение уравнения(i.ЧЛ) ,

шо вектор, отличающийся'от Т- перенумерацией классов,так-

является решением).Тем не менее при некоторых ограниче-

; на функции pi(X, t?) можно доказать сходимость- этого

оритма в вероятностном смысле к локальному экстремуму

кцни Vi(X)^

Для оценивания вектора параметров rft .особенно в

одномерном случае (X* 10, применяется также метод моментов.Пусть

"^еоть к -й момент случайной величины \t имеющей плот-

Згйость распределения pC^c.f), m,fc = Е ^ . - Очевидно, СИ*

^ееть некоторая функция от параметров Т", Mx^*^ fir) .Заии-

В&м еиотаяу уравнений Ягie ft(***),..- i W"^»£^t)( ty -раз-

ерность вектора 1Г), Если эта система разрезшма

относительно Тг ,

32

то поставляя в(1.Ч.5") вместо моментович,.~ ,m», их оценки,

построенные по выборке,^"te^£■ X-v ; подучим оценку****,

вектора T- tПоскольку,согласно закону больших чисел, оценки

моментов сходятся при у^-+о* к истинным значениям моментов (ло

вероятности или с вероятностью X), то при определенных

условиях на гладкость функции Т последовательность

уТ^Лсходится к *"t^ в-том или ином вероятностном емыоле.

1.4.3, Вариационная формулировка задачи самообучения

Веди нет оснований предполагать,что плотности PiC>*i,^)

имеют заданный аналитический вид,то можно сформулировать иеиара-

метрический вариант задачи самообучения.В основе такого

-подхода лежит понятие функционал среднего риска[ъ1Д22]Д£5"]

в'связи с чем он называется вариационным подходом к задаче

самообучения.

Зададим набор функщйС^(Х/"^ц),имеющих смысл

"расстояния" вектора признаков *Х от некоего обобщение?о "центра"

Tw i -го ютсса.Пусть |Xi\= \Х*,. . ^ХрЛ-р&збиение ^прост-.

ранства признаков К. на М непересекающихся .подмножеств.

За' критерий,характеризующий качество этого разбиений,примем

функционал

м .

- i-i x; '

Еадача самообучения заключается в нахождении такого разбиения

Ли таких "центров" Тг(1\ которые мшшмиеируют функционал

И .Полученной оптимальное разбиение к позволит производить

автоматическую клр.ооификацию объектов.

I*

33

Функционал (1.Ц.&") естественном путем возникает на -ооно-

||_ ве байесовского среднего риска (1.1.4} .Поскольку в задаче

самообучения -у нас все равно нет информации о принадлежности

.^объектов обучающей выборки к классам,то нет-смысла-и

расписывать функции di(X) из (1ЛА) в виде (i-3.3) .Вместо этого

Щ, мы предполагаем априори,что функции d i Ox) имеют заданный

f аналитический вид сЦСХ-)= tyiCVbtnrO*) и приходим к

функционалу (1-Н.6).разумеется?при этом мы уже. не знаем,соответ-

-^2 ствует ли оптимальное разбиение,построенное на основе функци-

Щ, онала С i.M.6),истинной структуре классифицируемой информа-

щ ции.

Используя Лемму I.I, лет^о доказатъ^о при фиксирован-

"^'ных'С(''разбиеш1е, мшшшзвдкщее R-, »Шет вид;

■ {f'",

_(«>

1-

(1.ИЛ)

^Используя эти соотношения,мояно исключить IXi^H3 числа неза-

^вйсимых и тогда критерий качества в задаче самообучения

примет более простую форму:

м »

V.M = Т. Ъ а (Х/^>)р(аа)с1х. (1.ЧЛ)

Условия экстремума атого (функционала даются системой

|_уравЕенийЧ

Вывод этих услоиий в общзл видз довольно славен Сем Г221 ),

Поэтому • здесь fie приводится .Зис.оото этого мы рассмотрим жрос-

! частные случай.хорошо иллюотрирущиЕ суть дела.

34

Пример. Пусть М^й,^ 6 В. множество Xi имеет вид

Х("|х: Х>Й-| .тогда

Б.» Б(й-/Й = ^^(x^^Jpcodjdon +

А-

Приравнивая к нулю частные производные от R noa. at

„получим*

U»(<vt-(t))-(k(ftA-(1>Jp(e4*c>,

Предполагая,что p(ft,) yl 0 (s области,где f>foe) eO .ггашиау

можно проводить произвольно).убеждаемся,что условия Ъкстре-

мума состоит из равенства (1.4,4^) и уелови.ч^(Ж,'Ь'")с|^(г,"гя{)

на грейте множеств A,, Xt .Но яла (й'нкщоналв (i.4.%)

последнее требование опр&шддиво по определению.

Применение алгоритма Роббииса-Яонро для ршпонда уравнения

(.1.4.4) дает рекуррентный аймрнтм самообучения

Сйлраулируом утаерждони'е о.сходимости этого алгоритма

самообучения»

'Неровна 1.3. Пусть ввнолнеин следующие условия:

I) плотность р(*) отлична от нуля на огрмшченном йноадоюе

А .обучающая айорка*«,... ,9Си еоетсглейа из неайшсимкх

одинаково распрэделзннвд с плотностью р(эс) , векторои"!

Z) фикции «Щзс.^У даК-ерешаруем! so втором;- «ргуменгу и

Vytyiftc.ty) удавдзтвврии усетяда йикмща

выполнено.условие

Тогда с вероятностью X существует конечный предел

li^n- &(^) = Е.„и на некоторой цодноследоаателшости И-^

кэчания, I). В теореме не утверквается^оходимость самой

Едовательцости т„_; алгоритм (i. N. io) сходится в ошо-

I сходимости последовательности значений функционала. При

1(1.4 И) означает,что нрадел R к является етащонар-

: значенном функционала £(тг) (но не обязательно глшшмумом).

К Условие 3) .твореыы 1.3. может быть заменено на одно из

.*** XiCt-)

; -г- fe T йТ„бТ, Уи, 1Щ?и атом утверждение теоре™

а*еея справедливым.

Доказательство ^сремы 1.&, основано на методе стохас-

кой шщроиснмшда. Ввиду его громоздкости оно приведено

жжении 2»

36

Fadoia алгоритма (1. Ч. £ о) проходит следутлм обряяом.

Па П. -и и.гв м;! имеем оценки параметров Т., ,.. . , т£Г' в

иа вход алгоритма поступает, точка обучапаей выборки Ж» .

Вычисляются эпачения фрюиЯ<Ц(Ж»,Т,,1и>)1 и ос' относи-

оя х классу о номером^-Аг^»Ч«п-<}'1С*»Г'""^Парамотр Т^'

иеняетоя согласно формуле (i, ц. io) иа

величину,пропорциональную JV .остальные'^* (t^*) не изменяшоя.Лоиуотим^

что в точение нескольких последователышх шагов изменялся

параметр одного и того же класса. Так над У«, умевшается

на каддом шаге,то последующие изменения параметров других

классов будут малн.это замедлит сходжостъ алгоритма.Поэтому

обычно пользуются модификацией ачгоретма (14. Ю),в которой

If», свое для каждого клаеое: *

£ ^11' - t еоЕь число точек,попавших в класс i зв Л.

шагов алгоритма ).

Рекуррентные алгорит.\ш имеют преимущество в экономии

памяти ЭВМ и простоте реализации.Однако, теоретические оценки

и практика показывают,что такого типа стохастические

итеративные алгориплы сходятся довольно менлениоЛюатому при не

слитом больших объемах обучающих виборок млеет авдед

стремиться к повышению эффективности ол-ropjrar эч счет змнишю-

кия и более тцатеЛьноЙ обррбэгки всей (хЗучпюцеГ: выборы*«

Рассмотрим метод построения шрегу^рен'гнюс мгоштасг. в

роаках вг.риашонпой ^орм;глпрспш задсчи самообучения. Ййче-

. 3?

даиа функционал среднего риоиа (I. ЧЛ) его оценкой-,построенной

по обучающей шборке X $ ,.. .*, Xjv ;

Согласно эакену большая чксел.Ц* fr"5 ^^"liCc-) с вероятное

отью I» До этому, если Тч. -эиление, доставляющее минимум

функции £и(Тг) .то при больших н. оио должно бнтъ близко к

'г; г=Лга Vrvin. &Ct'). Подобчая зшеяа неаззеотгого

функционала его оценкой} носит название метода минимизации-

эмпирического риека и широко испольэуетса в теории сценивашш Е5"] .

Фактичеики истод максимального правдоподобия является ч-ютним г

случаем минимизации эмпирического риска 1(см"# раддзл 1,4,Я).

;хшс,иам необходимо ш-^^зйрошть^щецию Ц.ЧЛЧ); за-

/дача 3ia осложняется паличиак разрывных функции *3^ (t>)&4

р Для ее решения иеяолъэуется гак наливаемый метод динамгчеокой

г^утшароЕки,которые предлагает оледатощий зтеративннё алгоркамг

дусть T-g -приближение,получеешее за S итераций, гогда&41)-е

приближение ищется как решение акстремальаоЁ задачи;

tti: как здесь ранение {XitT'j^} зафиксировано,то роить .

■Ту задг<"у намного проще,чем жходнув.яе многих случаях для

'•едого достаточно решить систему*

Z \1Ч) (хо V> %i (»«. ,^(11) - о, i«f,.. .,M.(ti.i6)

?Докатвм су'одш.гасть алгоритма дикамичеокоЯ грунпировгг.

feopsBa, F,4. Если Т^тройтел как ревеяие.ясотремьльяой за-

BflSra<t,4.15) ,то пгедедоватблЬ1!ооть(Е.я('С1^}являето(» навоэрао-

38

IvOJETj» ! -решение CUCTStn (1,4.16) ,8 JjyuiuiM <{{(»,f'0)

удовлетзоряэт условиям

(т.е.являются внлуюи&ш), to iraate ощшвадлтео (1.4.1*)

Доказательство: Применяя Лемму 1.1 д.!ся

ползшем

Уч1Глшай,что 't'j* j, -рыкание экотр&мальиоа задачи (1.4. is) t

у&вд£.емся в справедливости неравенства (1.4, it) .

Если выполнено (i. Mil) и t^j -решите сйстегда (1.4. i&) »то

39

ч*о пош-одователыюсть R n (TTi) имеет предел (при

' g_-e ),поскольку она не возо«стает и ограничена снизу. А

{рак Kait множество всевозмсшшх раа'йявакв обучающей выборки

. .,х„конеч1ю,то эта последовательность на некотором ware

fj,-t>" стабилизируется.

ГЛАВА II. ЩШКИ ТОЧНОСТИ АЛГОВШЗ РАСПОЗНАВАНИЯ.

МОДЕЛИРОВАНИЕ НА ЭВМ

2Д. Оценки достаточной длины обучающей

последовательности

В главе I мы рассмотрели множество различных методов

построения решшщх правил. Выбрав подходящий алгоритм и имея в

своем раопоряжения обучающую выборку мы можем оценить решающе,

правило и тем оамым решить задачу распознавания,Но можно л*-)

гарантировать,что найденное решение будет действительно

оптимальным? Практически вое алгоритмы являются асшпто'глчес-

кими.тс есть лишь в пределе при неограниченно!^ возрастания-^

длины обучающей выборки они приводят к теоретически

оптимальным разделяющим поверхностям.В нашем же распоряжении всегда

имеется обучающая выборка конечной (и часто - небольшой)" длины

Итак,основной вопроо.на который надо ответить - сколь

точно можно аппроксимировать оптимальное решающее правило с

помощью решающего правил а, построенного по обучающей выборке

конечной длиныТ-Чтобы придать этому вопросу точный с.ю/ольо6;/1~

тимся к статистической формулировке задачи классификш^ш.Нам

задана векторная случайная величина ^ ,значение которое

есть вектор признаков объекта,поступившего на вход опознающей

системы.и случайная величина tf , значение которой есть номер

класса,которому принадлежит этот объект.Необходимо найти

решающее правило ££к-/Т") .минимизирующее функционал среднего

риска

R(f) = Elt[-l(^)]2 (a.i.i)

Это решающее правило и является оптималь^-йй

Для решения ?тп? зйд?чи у нас гс-теется обучею^я последо-

41

вагсльноотьXt,,..,Эй*,векторов признаков К 'объектов.для

каждого из которых известна его принадлежность |1(,,, f •? ^.

Рассмотрим оценку функционала (2.1.1) .построенную по обучаю-

%:

IBi. л принем за оценку оптимального значения параметра тч =

&--=ОЛА Trun-Hfrc) то значение,которое минимизирует, вмшри-

"чёский функционал ореднего pH0Ka(2.t.£):Tw=<W#mj.>i-£;"ftr').

.Hp'ifeK упошгаалооь ранее,такой подход называется методом

минимизации амцир.гчеекого риска.

Согласно закону больших чисел,выборочное среднее стрзмит-

: к математическому окиданир.то есть5.»(гс)-»Жтг)!1риИ,—»■» .

£>-Что справедливо при любом фиксированном f .Однако следует

„что т\ и *с будут такие близки при больших к?

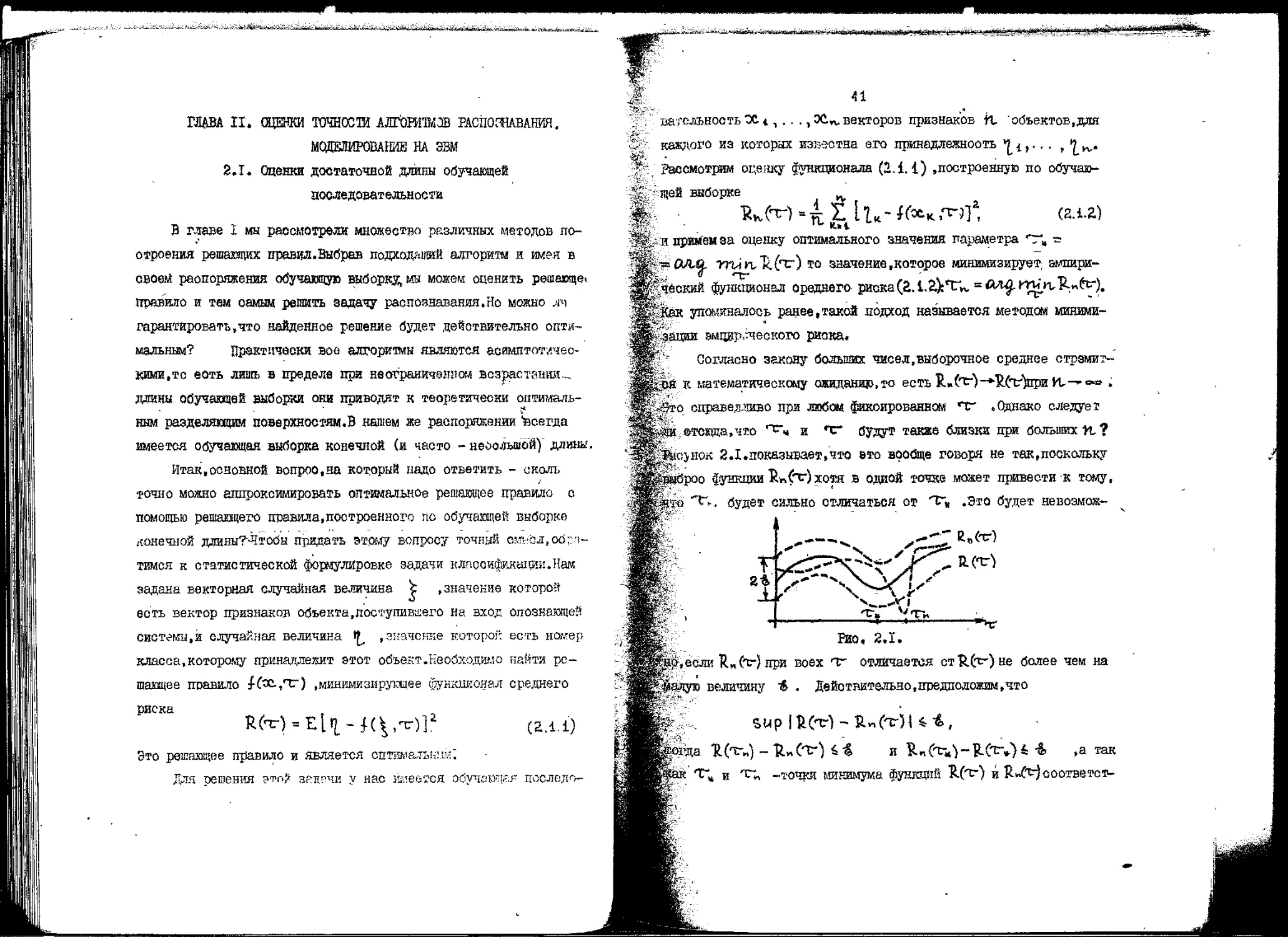

;Bicjhok ЙЛ.показывает.что это вообще говоря не так,поскольку

КЙайроо функции £и(т)хотя в одной точке может привести к тому,

bfjifl 'С-. будет сильно отличаться от Т« .Это будет невозмож-

i

г £5

*!>'"*'

•^

4-V

—Л*.

■''F*'

'"П.

К.Стг)

Р.(тг1

. "*!■

Его. 2.1.

НО, если R „(f) при воех тт отличается ст'Я^тг)не более чем на

Ц$адую величину * . Действительно,предположим,что

suplfcCTl-W-rilH*,

адда ТЦтг„) - Ъу~(Ъ-) i% и йпСтт.^-ЦСт-.Н * ,а так

Т"» и т» -точки минимума функций Щт) и R»ft^oooTBeTcT-

42 -. ■;

'венно.то Я(тг») « И(т») , В.«(Т^ 4К.-(т-»,'!.Из этих

четырех неравенств непосредственно вытекает:

Таким образом,необходимо.чтобы вшшрнческий функционал

еходился it теоретическому равномерно по Т" »то" есть должно

они.

«^р{вир|ц.„(чг>-я(тг)и*> = 0. (a.i.»)

ft-* •# '■t J

функционал ореднвго риока гфодарционален. вероятности

неправильной классификации (см. (iЛ. А) ) .Эмпирический функционал тогда

щюпородонален. -частота неправильной классификации,вычисленной

по обучающей выборке .Следовательно, выяснение условий,при

которых имеет место(2,. 1.Ъ) .сводится к решению вопроса о

равномерной сходимости частот событий к ох вероятностям.

Пусть задано реаающее правило $(&,-?), Каждое значение

параметра ТГ определяет ообытие А(т) .заключавдееея в том,

что вектор \(и))непра&1ЛЬЕО классифицируется решающим правилом

i-C&fe). Когда Т* пробегает все множество ■значений,мы

ьодучаем семейство событий S = {A^t* )%*t*« Ц*г j. .Равномерная

по t* сходимость функционала UnCt*) 'эквивалентна

равномерной по семейству S сходимости частот событий V(A)к

вероятностям V(Pi) .Иначе говоря,нас интерооует сходимость к нули

максимального по классу S уклонения частота от вероятности:

PfttfOl **}.-*£, rae^r^SUg^CAbKA)}*

■й»(А) -частота появления события А на выборке длины "К .

Классичеокая теорема Бернулла [Zt\ утверждает,что для

любого фиксированного события А

однако не для всех беоконечанх семейств событий имеет место

равномерная сходимость (см. [5"1 ).Ъ простейшем случае,когда

S состоит из конечного числа событий^ равномерная сходимость

-вгда имеет место и можно дать оценку величины уклонения

Теорема 2.1.Для класса ообнтай S .ооотоящеи нз Л

Доказательство .Случайная величина j*(A) имеет биномиаль-

'^Ье звспределвние

тому <

P(li(Al-PCA)|>*} = £'^P"(A,)U-P(A^-,:

сумма берется по к ,для которых 1я - Р(АТ| * в.

i Sup 1$я,(А) - Р{АМ > ft } означает.что по крайней

для одного из событий А(,.,.,Алсправедливо неравенство

По тесреме о сложении вероятностей

f{nt(H.)t>*}*jtz'c^p,'a)H-p(A>r;"

В силу интегральной теоремы Муавра-Лапласа lZt\ правая

. этого неравенства может быть оценена сверху величиной

Sa»?(A)U~ Р(А)1 -диспероия случайной величины 1)»(А),

имальное. значение величины С равно g (при V(k) = jr)j

и

Ч1ри достаточно больиюс И. ( И>1 /йр"** )отоида

получается неравенство (2.1.4).

Рассмотрим бинарное пространство яриэиаков.Б котором

значения компонент векторов признаков равны либо О либо

I,как,например,для пероептрона Роэенблатта.Так как всего существует

' 2/* различных .М -мерных бинарных вендоров, то число их

разбиений на два множества нонечнэ.Б частности,чиоло разорений с

томощь» линейных правил К < 2, .Потребуем,чтобы вероятность

Р{8ир1^н.(Ак.)-Р(^«:)|>*} не превосходила заданноге

числа^ :

p{supli(AO-P<A«>l>*}<t-

Согласно(г.1,М),8То будет иметь место.еоли

Разрешая это,соотношение относительно & либо -С ,при~"

дем к еледуинему рез/льтату^сли из конечного множества /J

решЕлцюс правил шйкрадфся кр&вшло,которое на обучающей выбор

ке длина & 'имеет наименыау» частоту ошибочной клаооафйкащш

У ,то е вероятность» "i - *£ мсянд утвервдать^что "Ц

отличается от вероятности оидбкн сптаиального решающего правила

Ее более чем на велнчйяу

о другой стороны,для того.чтобн о вероятностью \~ £ частота

отличалась от'вероятности ошибки не более чем иа & ,обучак-

Яьй выборка должна иметь длину не менее

{ 4 еоть точность избранного рещаадэго правила, а £ -надеа-

воо:ь :

т£

.« Если число решакщах правил бесконечно,то получение оценок

ИпвСг.С^ораэдо сложнееГВместо К. в етом случае вводится

[вивальная характеристика - функция роота.Развитая в С У] те-

равиомерной оходамооти частот событий к вероятностям при-

т к вняопенгав необходимых я достаточных-условий равномер-

еходимостк.а также дает опенки точности приближения час- i

5 к вероятностяк.Полный вывод этих оценок и условия о.чода-

Ш довольно сложен.Зцесь мы его приводить не будем.ограни-

:ь рассмотренным простым частным случаем конечного ыао-

правил.хорошс илдвстрирувдим основные моменты,1

В качестве рецепта,которым можно пользоваться при выборе

обучаящей выборки и сценке точности алгоритмов распоз-

,прчведем слеяупцив резуаататдая линейных ретагарх

ш в пространстве R" длина обучаэде* выборки должна бить

if'roro,чтобы о вероятностью !-■>£_ частота ошибок эипнричес-

sro решающего правила отличалась от вероятности

оптимального решашего правил» не более чем на & .

: отсвка € через С (с пгчощь» неравенствами^ <j|:$,

i точность при заданной длине обучающей выборки:

Подробное наложение теории равномерней оходямооти и ее

$ний в раопознавания образов и теории етатиотического,

t можно найи в книге 15] .

46

2.2. Правило останова конечяосходяшихся

алгоритмовт обучения

Применение конечнс«чожящихс& алгоритмов в

детерминированной задаче обучения гарантирует отыскание разделяющей

поверхности за конечное число шагов алгоритма.Но каково именно это

число шагов - неизвеетно.Более того,далее если мы сможем

оценить число исправлений,которые претерпит вектор параметров Т",

мы не сможем сказать,когда же остановится процесс обучения,

поскольку это зависит от опоооба выбора обучавшей

последовательности.

Еоли наложить определенные ограничения на отатиетику

показа обучавдей выборки,то можно гарантировать с большой

вероятностью достаточное качество разделяющей поверхности.Мы

будем предполагать,что обучапдая выборка выбирается как последо -

вагельность независимых случайных векторов,распределенных о

пломостьв Р(х) на множестве X. Цуоть }*(х-) -разделяющая

поверхность,а f -вектор параметров.поотроенный о помощью ко-

нечносходящегося алгоритма.Качество ревевшего правила f(cc,nr)

определяется вероятностью ошибки:

Сформулируем следующее правило останова:алгоритм обучения

останавливается,если после некоторого к -го исправления в

течение Tn-'и) шагов исправления не происходит.Покажем,что при

С9ответотэувдем выборе ф/шштШ-С*-)можно е.большой иадеж-

ноотыг гарантировать высокое качество разделяющей поверхности.

Теорема 2.2.Дуоть в правиле останова

47

Зав 0<^*1, и, -любое целое число, И->1( ^(n.) s.Z pi —

: ^ункпЕЯ Вмана. Тогда справедливо неравенство;

P{£'(f)**} >i-l. (г.гл)

Доказательотво.Пуоть Тг*к -вектор.полученный. после К -го

ленкя.Вероятнооть тоге,что останов ироизойдег после к-го

ления(но до (К41)-го),равна Ц -^jtftv.)]"""Чумовная

ятнооть трго.что алгоритм остановится яри условии,что ка-'

Ьтво разделяющей поверхности ^tCtV) =• Ц-,равна

ложим.что случайная величина $ГСпО имеет юютнооть

расселения <},ty),тогда вероятность того.что алгоритм оставо-

йтся на векторе,для которого качество решающего ярааила боль-

^другой оторрнн.эта вероятность равнаl-p^fflr) 4 А} ,

f -вектор к* С*-2-^Выверен йгякянв Ж-(К) из условия

\m-CK)

|1; Л- подберем так, чтобы

Й-ен.ои.ен.^-^н^и) )Соглаоно(г.а.а) wtflQ-^flffigS

;|ть совпадает о выражением (гДЛ).При этем выполнено не-

|нство (а,2.2).Теорема доказана.

gS качестве примера эаиетим.что § * ^- при и>« 2 .

48

2.3. Моделирование процеосов распознавания

на ЭВМ

Для иооледования овойотв алгоритмов распознавания удобно

пользоваться специальными модельными масоивами информации. О

этой пелью на ЭШ генерируют данные, обладающие требуемыми

статистическими характериетикамиЛо результатам применения

алгоритмов распознавания к этим данным можно оценить эффективность

выбранного алгоритма,подобрать наилучший алгоритм для решения

определенного крута задач и т.д.

Методы получения числовых последовательностей о

требуемыми статистическими характеристиками и их использование для

решения различных задач составлявт предмет метода отатиотичее-

ких испытаний,или метода Монте-Карло {el, 191.мы рассмотрим

йдесь некоторый круг вопросов этого метода.которне будут но-

лезны-для моделирования процеосов распознавания на ЭВМ.

2.3,1. Генерация псевдослучайных последовательностей

Последовательности чисел,обладание статистическими

свойствами случайных величин,называют псевдослучайными последова-

тельностями.'Оказывается, задача построения последовательности

с заданной функцией распределения сводится к более простой -

к построению случайной последовательности о равномерным

распределением. ^

Теорема 2.3.Пусть задан набор чисел \ *0, 2И рк = i,!

и ^ -случайная величина,равномерно распределенная на

интервале [0,11 .Тогда для случайной величины \ .определенной

соотношениями

1=К .если £Pi«%*XPi. (a.S-t)

43

дливн равенства) P П * ^ { = P* , К » 1, ...,//,

Доказательство,Нескольку

H1S0C1"X. же№П, (г,.ъ.г)

= р{}*|М~р|1фф

Теорема 2.4.Шгсть ЩЩ-монотонно возрастающая йгнкцня

^деления, | равномерно распределена на [0, i~\ ."Тоща

ная величина *[ = G *( ^ ) имеет функции раопределения.

Доказательство. (Заметим,чго,функция U" , odj твая к &,

*твует и также является монотонно возраотающей.в силу ра-

(2 5.2)

P{^x} = p{r,-'(|)43e} = P{^G('K)bG^>i

й требовалось доказать.

Поскольку в математическом обеспечении довременных ЭВМ

стандартные программы генерации значений равномерно

военной случайной величии',то -задачу "построения-оду-

t последовательности о любым заданным распределением нок-

:ать практически решенной".

-*В .некоторых случаях обращение функции £ может быть

сложвым.тогда для построения случайной величины прибе-

'к специальным приемам,Рассмотрим, например, поотроение нор-

едучайвнх пооледовательностей^Есдй. £ „ равномерно рас-

,*енкяа[0,1] ,то

50

Согласно центральной предельной теореме,случайная величина

имеет при достаточно больших tt распределение,близкое к.

/\f(0,1^ ш достаточная точность лодучаетоя уже приК=10;слу-

, чайная величина ^ о раопрьделеняем''(й.О'2) получается из

стандартной нормальной величины V во правилу^ »W 4 + О, .

Набор -J = (^^.1, ^)незавиошшх стандартных норчальнвх олу-

чаВннх величии образует W нквтанй BeKTOji о нулевые средний в

единичной ковариационной матрицей.Вектор \ - В^'+ <*- имеет

нормальное распределение со средним вектором Л. и матрицей

ковариаднй ВЬ .

2.3.2. Интегрирование по кетодт Монте-Карло.

При оценивания эйектигнооет ретагашк правил приходится

вычислять вероятность неправильной классификаций,а это

приводит к заделе вычисления интегралов от бувкщя» многих перемея-

них по областям,кмепким иногда довольно сложный

вид.Аналитически ваять такие интегралы не удается и приходится прибегать

к приближенным метсдам.Одюш из методов численного иптегриро-

вавяя является использование поевдослучайгах последовательно-

отэй.

Пусть требуется вычислить интеграл по

области X ь R," Доли \ -случайная величина с-: влотностьи

распределения Pf») .отличной от нуля на «яокеотве X , то

Это соотношение указывает на способ приближенного внчислевия

интеграла,поохольку в силу закона больших чисел выборочная

51

■Ш опенка математического ожидания ояучайной величины f(f VP("5)

Ж сходится к •зш.

Теорема" 2.5.Пусть Xtl - -. , ^^-последовательность неза-

случайных величин о плотностью РСс), сосредоточенной

^^яа множестве X С Я .Положим

*^д^огда для любого О <. & t 1,

Щ'_ Ц1^-эши^£ }>i-S (г.э.а)

fr^ Докдоательетво.Теорема представляет собой просто

формулировку закола больших -чисел в форме Чебнцяда t&O^fa?] для кон-т

Цветного олучея.Упомянутцй а&^н утверждйет^что дхя неЕавися-

^<4?далс одинаково распределениях случайных величин ^ и, со средним

&. и дисперсией S"

-cM*VfiM-«.

как легко убедиться, Т> ш есть дисперсия случайной вели-

5*шшКх».)/КЛ.»).

уормула(г.1.3) дает возможность оценить длину последсва-

Ц тельнооти 3it,,.. . Хп,необходимую .для прийшжения интеграла

.■3(f) о требуемой точностью.Однако зта оценка является силь-.

'но эав«1тецкоЕ. Лучшую оценку можно получить с помощью цептр&ль-

|* ной предельной теоремы,согласно которой величина

/живет при больших п. распределение,близкое к нормальному о

Рунулезш средним л единичной дяояероией.

ГЛАВ* Я1. РАСПОЗНАВАНИЕ ТОЧНО РАЗДЫШМЛ КЛАССОВ

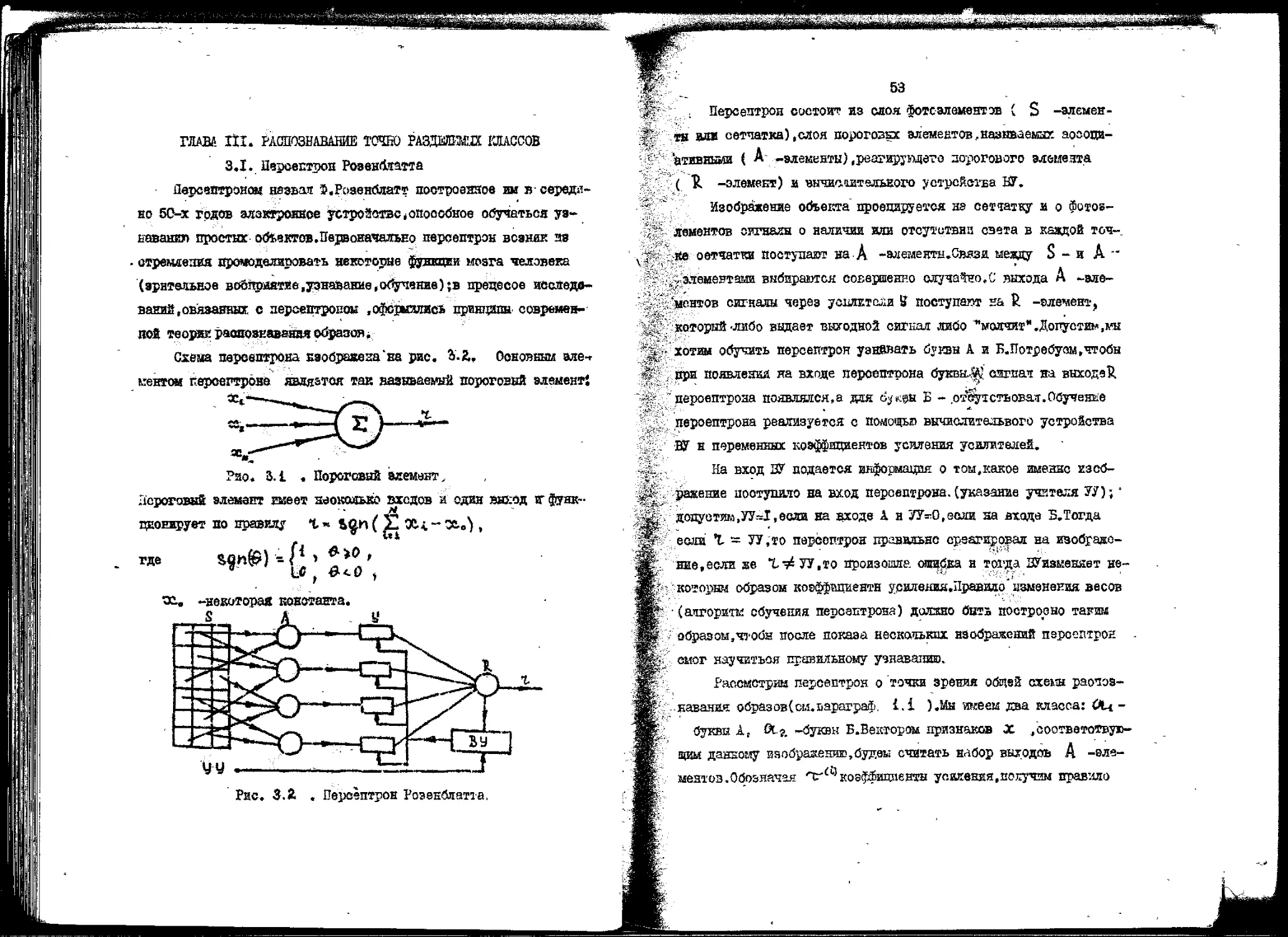

3.1. Иероептроп Розен&гатта

Дерсмгероном назван },Р{)зенбяатт построенное им всервдя-

но 50-х годов электронное устройотвсопооойное обучаться уз-

ьаванпл простых ой^вктов.Первоначально нерсептрэк возник as

■ стремления промоделировать некоторые $$нкпии мозга человека

(зрительное вобяривтйе.уэнавание.офчение^в прецесое

исследований,овязаянш с персептровов .офсцсншс! принципа

современно* теории раопознаввяачойразов.

Охеаа пероептрона Езойрввена'ва рис. 4-й. Основным эле-,

гантои героегарова является так вазнваемнй пороговая элемент!

Рао. 3.1 . Пороговый мемаът,

Зсроговнй вленант гмеет аюкояые входов и один внход «г

функционирует по правилу г - bg.n ( £ Х<, ~ Зй„^ ,

где 4»»)i ft'*»»'

-некоторая константа,

S

Рис. 3.4 . Переёптрон Роэенолатта,

W

тш?

53

Переёптрон состоит? из слоя фотоэлементов С S

-элементы ил* сетчатка) ,слоя пороговых элементов, назнваемах аооопи-

'атившаш ( А -элементы) (реагируэдэто до-рогового элшеята

( Ц, элемент) и вичисштельного устройства КГ.

Изображение объекта проецируется на сетчатку и о

фотоэлементов сигналя о наличии или отсутствии света в каадой точ~.

т сетчатки поступают на А -амемеитн,0»взя мевду S - и А "

,, элементами выбираются совершенно случало «.С выхода А -эле-

'мрнтов сигналы через усоагктслн 5 поступают на £ -элемент,

который-либо выдает выуодной сигнал либо '"шлчнт*'.Допустим,кы

. хотам обучить переёптрон узнавать буквы А и В.ТТотребуом,чтобы

при появлении яа входе пероептрона букв&0 сигнал на выходе^

пероептрона появлялся,а кяк %^©ы £ - ,от%тстьсшатг,Обучение

пероептрона реализуется с помощью вычислительного устройства

ВУ н переменных коэффициентов усиления усилителей.

11а вход ЗУ додается информация о том,какое имение кзеб-

ражение поступило на вход пероептрона.(указание учителя 7У);'

допустим,УУ=1,если на входе Д. н УУ-0,если на входа S. Тогда

если % - ТУ,то переёптрон правильнс ерзагировал на изобрадо-

ше.если же Тт^УУ.то произошла ошибка н тогда ЗУизменяет не-

которнн образом коэффациентн усиления.Правило' изменения весов

(алгоритм обучения пероептрона) должно битв построено таим

образом,чтобы после показа нескольких изображений переёптрон -

емог научиться правильному узнаванию.

Рассмстрин персептрон о 'точки зрения общей схеш

распознавания образов(сы.ьараграф. 1.1 ).Мы икеем два класса: #Ц -

букш Ае ^-г. -буквн В.Вектором. признаков X /еоответотвую-

вдщ данному изображению,будем считать набор вьцгодоь А

-элементов. Обозначая nrtv) коэффициента уаакеняа,похучаи правило

54

функдаонироваиия R -элемента (через t°i обозначено

количество А -элементов):

N

Задала обучения переептрона состоит в построено такого

ректора весов тт ,что

( >,о для, «tXi,

' <0 для, ХбХг,

где />i -множество в R.", соответстзущее объектам класса Ok-

I.Воспользовавшись теоремой 1.1.,доказать,что оледувдий

•иггоритм обеспечит оходимость процесоа обучения пероелтрона за

конечное число шагов:

о _ | i, если_е^(тг,,а1„)г,£^

1 " ~ 10, есля ev>(o-„, я;„1 >£>,

и»_эе.. г" №F «

е»"-1 для бута А в<5", •-! для Б, fl««t<\&l .

2,Дня данного конкретного вида разделяющей поверхности

можно обосновать конечною сходимость более простого алгоритма

обученгаЦсм. \.5] ).

а-в,1=ти + Лте„, (o.i.i)

Нашей уэлью является построение демойстращошю* модели

персептрона на ЭВМ,

З.Яла моделирования персептрона на ЭВМ пестрой» слелувш!

алгоритм выччоления признаков, В .пом. ЭреийВ введет ка^ор

линий,называемых зондами, и будем считать -X,

равным числу пересечение изоораямиш с i -м зоэдом,Напасать йро-

гранту.ре&шзущуй вычисление таких признаков.

* _ 4.Написать програину для ЭШ .моделируацув персептрок.

if Изображение буквы должно взводиться на экран вместе с зондами.

fri Ввод маооива;опиоываящего букву,осуществляется о.перфоленты,а

^указание учителя вводится о пишущей мапшшеа.Обучение нереедт-

рона осуществляется в соответствии с лрьЕилом ('i.i.i),

б.Лодготовить обучающую ьиборку и провести обучение пер-

К; ееатрона.Если однократного просмотра обучаадей выборки оказа-

&яооь недостаточно,поморить оОучение.Для оценивания

необходимой длины обучаэдеи выборки воспользоваться результатами па~

'^вагрЕфа 2.2,

6,По литературе изучить вопроса о возможностях переелтро-

_на и о тех задачах из области физиологии^Ьтсрне привели к ево

«созданию.

Литература: 13] Д5] ,[14] ,122] 126]..

3.2. Конечносходящиеея алгоритмы обучения

распоззавЕЛИю образов f

Цель данной работы - исследование алгоритмов обучения ,пс-

jfc строенных на 'основе,двух вовечносходящахея алгоритмов решения

оиотем неравенств:

(X, W-'j * V > О

а также

(X, м)-ЦМ8г>0.

I.Проверить выполнение условий теоремы I.I.B предаоложе-

вии.что существуй такие w»V». и й„?0 .чтоУхаХ

fi(tt.tV|*(*.•«.) + V» >■*», т-[" J, (З.г.1)

^(■X.-ul^Cx.'U»)- Щ^И*»"*».'

(гг.г>

56

2.Пуоть множестваXi, Xt в нроотраыгае нризнаетв.соот-

ве^ствугаще объектам двух кяасооБ,разде.шш гиперплоскостью.

Ярииенить ж этэй задаче конечноеходгаиеся аягорилш.волучае-

-ннв из общего алгоритма (Ц.(>) ,(1.2. ?i дай &yrataje(4Zi.),(V1.2).

В первом случае яолучавтея алгоритм)

-и».!. •««+«& «Мл. л„, (5.г.&)

Й„ -указание учители ( I дяиХ„бХ4и -I для ijc^-Xj ),

' * 1.0 иначе,

Т6»^чиоло изменений векмра йареметров за « шагов5,

алгоритма, ^ в fes]?

Алгоритм во втором случае:

ы„41 - м„ + а„1>вв^(<11.в-а«.),

Иосг-едоввть геометричеокую интерпретацию эвя алгоритмов

3.Нависает, проградаы.реалгзуетда оба алгоритма (взять

j3 = tCn4*B качестве параметра лрогрзммы). Снабдить алгоритм

обучения правилом останова (ои.параграф 2.2.).

4.Смоделвровать обучающую выборку,йзваеченнт» аз двух

классов, разделимых гиперплоскостью.Длина обучающей выборки

должна быть выбрана в соответствии с 2Л.,Я.£.Смоделировать

акзаменационну» выборку и провесгй эюадврйнеит по обучении и

оценке качества распознавали.urrejseiypa: 1221 .

67

3,3. Разделение нескольких класоов

Пуста в детерминированной задаче распознавания число

классов М. больше" двух'. ~*Ддя этого случая иогут бнть предложены

различные метода построения алгоритмов распозвавашя(см,напрн-

г- иер,[?1 ЛХ21 );Мн здесь рассмотрим путь,естественным обра-

'' зом возникавший из общей вариационной постановки задачи классу

* фккавии,сформулированной г параграфе 1.3.

Дидполояим.что распределение векторов прюияков.соответ-,

^ствуичих объектам 1-го класоа,оосредоточено' на множестве Хц .

" пеней иножеетва.соответотвуящив раяличввм классам.не первое- '

IiSDynrana достоверяоота прияадле»нооти(1.з.З)превраие1)т-

cs в этой случае в нвдкатори «шожеста X t;

jic»)-^if«j-{o:**-'

.а функционал среднего риска принимает вид i

(i.u.)

(9.3.2)

Првднологим.что для каждой пара «иоавств Xt , Х«

существует разделяющая функция

- аналщт^ески? вид функша,Рк,; (ТС, тг") предполагается извест-

ннм.Эадача»таким образом,состоит в чахо*дениг аеизвеотиогс

векторного параметра ^м ,

Выбрей функции Скл.<х.,тг^ в(г.Ъ.1)сяедущим образом;

вв

j-:|

to , k = -i.

2,Из(З.З.гУ(>.1.4)ораэу следует

геем* XiCXiCt.).

Рассмотрим градиентный алгоритм!

tj.t ~т-„ +tXtjr.<""4x.(«-1|t()iltB.0(oB,)7cfKi(=u«1t-.y,

*<*«

X?"*i. K*i; K,i-1,...,M; £c'l> 6 [<U] .

Теорема ЗЛ.Чуоть выполнены следующие уоловия:

-I) feHKiniBl1ftii(X,t)|vtl?rfiii(ai,'r)e ограничены равномерно во X

13 X ';

2) существует вектор т; и число fe ;>о, для которых выпол-

... вево(5ДЪ);

■ !з5для лвййпарн точек|*,т^б?. х R. справедливы веравенотва}

Тогда алгоритм С5.1.Ч) является конечносходяиемоя.'Го еочъ

для любого т^е R г произвольной попледовательносшХ,,...,^,

Х^бХ найдется такое дало Л^ {эавиоядее otXj.,. ,.

.,..,»«, ....,t\;,«o

Доказательство.ilj'C'b на W -и ааге^Сю^З^^рс.,]-!,

5S

нек.оторвх K.,t i .тогда в оилутретьег^у&аовия:

»t„„ - t„ «»* Нт. -т. Ц** (xl™? Й^С*»^-!»'+

4 Итя -тЛг* (rf)* U^-Pti(Xn„T^H^

Согласно определению множеств Xi (tr) (имееи для i * К,'

Поскольку К ф i р то ореде множеств,стоящих сод знаком

пересечения, имеется множество > {С^;. <. О \ Л Х^ ' (соответству-;

ющеэ ). * К. )и следовательно,

3.~С помощь» условий теоремн и соотношений (3:5.*|)

/ценно доказать снраввдшвость неравенства

1Кч -'Т, И*Г H'CW -Т. И* 6 f**, .

где рад нз неотрицательных величин й*. расходится.Отенда и ,

следует конечная оходимоси алгоритма,Эта 'чао*ь доказательства

почти вэтяостьв повторяет доказятельствз теоремы I.I.

4.Язвестно,что в случае двух классов алгоритм ойучегоо» с

поощрением является градиентным для функционала

'см. 1*1 ,стр.й5).5тот фужцконал мояго цргаэотТ к виду

(S.4.-1) , ec.m m!OrraTbC!i(^.^)-*fc^,(Ui(sl.'^~

ее

б.Еоли разделяющая функция Ц5аСХ»"С) зависит только

от "овоего" параметра tit , «f,^ (X,Tr) - f „x (х,а-<(->),

<Г=1-г'0 К>ч.дД»1,..,М},ю (J.3.4) распадается наМ(М-1)/2

равенств для каждого из T(tU.PaccMOTpeTb частный случай

алгоритма (&.э.ч) ни равдедящих функций вида (M.i).CpaB-

нить этот алгоритм при М=2 о алгоритмом (4.2.S) .

Е.Напиоать программу, реализущув полученный алгоритм.

7.Смоделировать обучащие выборка для нескольких значений

;' М .-применить *с ним алгоритм классификации,исследовать его

сходимость.При определении необходимой длины обучающей поеле-

, дозательности воспользоваться результатами глфзы II,

Литература: ЕП, [221,

3.4. Построение кусочно-линейной разделяющей

поверхнооти

-До сих пор мв предполагали,что классы в пространстве

признаков разделимы о пояощьь. функция простого вида,как правило,

линейной.Что делать,если множества Xi, X&. не разделяются гя-

пёргогаскостьвТ Иногда и в этой случае можно свести задачу к

линейной,например,если и?вестно,что разделяющая поверхность

ямеет вид Xt^A-i (X) ,где | ft. i„(3t)^-набор лзвеоишх

функций» Вели сделать замену леремешшх X — ^ , y.w • <Х,\. ре.),

4.* {,...,£}. (которую обычно называют переходом в опрямляющее

пространство),то разделявдея. поверхность будет в новом проот^

ранотве гиперплоскостью.

Чаще однако не" удается указать тжЛ набор |й,;&$]до-

статочно простых функций,а приходится иметь, дело с нелинейкой

разделимостью множеств Xi , Xj. .Мы рассмотрим здесь один

из методов решения этой задачи,связанный с построением так яа-

61

' знваемого комитета неравенствЗозмакны и другие 'подходы.как

* например,в методе "обобщенного портрета"(см. 1^1).

Пусть в простравотве признаков К задано К гшгергаюо-

.'коотей (И."» се.)**»" «О,- 1-4,...,К.

Определение.Рбшашее правило вида

называется комитетом неравенств,основанным на принципе болышя-

отва голосов (или "Комитетом-!").Число К, называемое поряд*

ком номитета.ддя "Комитета-1* предполагается

нечетным.Очевидно, "Комитете" относи? точку, "X. в множество X», если для v

бслынизотва гштерплоскостей она лежит в положительном пелунро-

стройстве.

Определение.Комитетом.основанным не пркшипе единогласия;

("Комитэтом-11")аазывается решающее правило вида

■х. а Х4 , если (tct£>,'*>.+ **' > О дои воех*"1,.-Л

"Комитет-11* откосит точку "X. а Хг.если хотя бв для одной

гиперплоскости точка X попадает в стриительное полупростран-

cTBOiBastEHM явдяето! вопрос о сущетвовании комитетов.,

1.Доказать,что если выпуклая оболочка множества Xi

отделена полонительннм раоетокнием от множества Х4 ,то

существует "Кошшет-П"конечного irapwn», разделяющий" зга кножества,

,Для "Комитета-I" вU21 доказано следующее утверждение!

еыы клааси Х« . Хг. 01тжшчш№ и рбзделены положительяым

уаостоянчеи.то сущеоетует разделяяаиЗ их "Комитзт-1" конечного ,

Порядка.

Алгоритмы построения комитетов конструируется по анало?»»

е чоиечносходя1,!ккся алгоритмом (й.й.З) (при At» i. комитет пре-

И*->

вращается в ^делянцу«кпшер]иоскость).Пусть ооучащая

выборка **!,'■.. , *-п, навлечена та двух яепереоекащяхоя множеств

X i, X л #Д?я когорта существует разделяиций комитет порядка

К., и пуста f {*•) -какая-дийс разделявшая {ункпия,

>0 для oceXi,

< О для ЗС в Хг ,

%рть к .КС -му шагу алгоритме построен наборов',$J',-t*i,...,к}.

.'Для "Комгаета-1* вIX21 предложен следующий алгоритм.

Чиж' ^(x„)^MJ»l(«li>.-*,w>+tfia'l>0.

so<^i»W. ^5"^. <.-1,...,1С, '

В противном случае' параметра гиперплоскостей переечятшмштся.

-Зредподожт.что *»2.U * i .введен числа

в упорядочим юс по величине.Пуоть Ч*' * 0, • ■ ■, '£Z) s О , -

a it"' >0, • •. ,- l"u* lV>0 (miL+i .).Тогда

«,a<j>, «& - W

i-i^.-.u,"1*!,---^!-*!;

,гй

«W-*1"1-^ -TTPS5»

|jvt- i»L+i,-

. Аючритм построения'"Кггатета-П'геОЯн

5(3

: .-.IP

*Q'-«»i

И1Ч1

,c'b

- *?•*■-£-. f?tr»

Льва

й1 = f 0, если («!?, л.) * Л" ^ wvfM.Kuf'.x.)* Vl%

Эта алгоритма носят вврястагаеонни хьрактер.доказательотво

тс сходимости отсутствует (теорека I.I. здесь

неприменима).Белое того.извеотин, прине!» ннмеотв Xi, Xt.когда сходдгооти

нет (си.[г21 ).Однако,вкспершенте ва ЭШ показывают,что в

вольявдаетве ситуаций алгоритмы работаю достаточно надегао.

г.Иооледовать геоиетричеожую интерпретацию алгоритмов -

<ом.1Ш>«

З.Нашсать программы,реализующие алгоритма построения

комитетов.

4.Получить овучьпше выборка для юкяеотв.раэделиинх с

лсиощье комитетов обоах типов.Применить к ним алгоритмы.ис-

оледовать их сходимость.

Литература: [51,[22].

СТША IУ. BEPfflTHOCmffi МЕГОШ ПОСТРОШЙЯ

ишпих пшад

4;1. Метод максимального, правдоподобия

Пусть имеется повторная выборка OCi,.,., Хк

-последовательность независимых одинаково распределению; случайное вели-

. чин.Цредпошжим.что задан аналитический вид п плотности

распределения РСх) ,то есть онг известна о точностью до

некоторого параметра Т"

Р(х) = р(х,т), тге Rp.

Необходимо построить-оценку неизвестного параметра т~

Одределение.Опеяков максимального правдоподобия, (о.м.п.)

называется значение т- доставляющее максимум зЕуякцш

правдоподобия ft РСХ^Т") ил»,что'.: то же самое, догари^шческой $унн

цки правдоподобия