Автор: Фомин В.Н.

Теги: регулирование и управление машинами, процессами кибернетика теория автоматического управления

Год: 1984

Текст

В.Н.ФОМИН

РЕКУРРЕНТНОЕ

ОЦЕНИВАНИЕ

И АДАПТИВНАЯ

ФИЛЬТРАЦИЯ

В.Н. ФОМИН

Рекуррентное

оценивание

и адаптивная

фильтрация

МОСКВА "НАУКА”

ГЛАВНАЯ РЕДАКЦИЯ

ФИЗИКО-МАТЕМАТИЧЕСКОЙ ЛИТЕРАТУРЫ

1984

31 81

Ф 76

УДК 62-50

Фомин В.Н. Рекуррентное оценивание и адаптивная фильтрация. - М.:

Наука. Главная редакция физико-математической литературы, 1984. - 288 с.

Книга посвящена последовательному изложению ряда разделов адаптив-

ной фильтрации в условиях параметрической неопределенности о помехо-сиг-

нальной обстановке. Материал книги группируется вокруг вопросов рекур-

рентного оценивания, при этом обсуждаются как хорошо известные схемы

оценивания (метод стохастической аппроксимации, метод наименьших квад-

ратов, метод максимума правдоподобия), так и относительно новые схемы

(минимаксное оценивание, метод рекуррентных целевых неравенств,

робастное оценивание). Значительное внимание уделено методам синтеза

оптимальных фильтров (фильтр Винера-Колмогорова, фильтр Калмана-Бьюс и).

Принятый в книге подход применим к многочисленным задачам оптимального

обнаружения, обучения распознаванию образов, идентификации динамических

объектов.

Книга предназначена для инженеров и научных работников в области тео-

ретической и прикладной кибернетики. Она может быть полезна студентам

старших курсов и аспирантам, специализирующимся по математической и

технической кибернетике. Библ. 243.

1502000000-057

ф --------------133-84

© Издательство"Наука”.

Главная редакция

физико-математической

литературы, 1984

053 (02)-84

ОГЛАВЛЕНИЕ

Предисловие....................................................... 7

Введение.......................................................... 9

ГЛАВА 1

ЗАДАЧИ И МЕТОДЫ ТЕОРИИ ОЦЕНИВАНИЯ

§ 1.1. Примеры задач оценивания.................................. 14

1.1.Г. Оценивание величины постоянного сигнала, наблюдаемого на фоне по-

мехи (14). 1.1.2°. Задача оптимального оценивания параметров сигнала

(15). 1.1.3°. Задача обнаружения сигнала (15). 1.1.4°. Задача о разладке

(16). 1.1.5°. Аппроксимация функции с помощью линейных комбинаций из-

вестных функций (16). 1.1.6°. Модель обучаемой системы (17). 1.1.7°. За-

дача самообучения (21). 1.1.8°. Идентификация динамического объекта

(24). 1.1.9°. Синтез адаптивного управления динамическим объектом (25).

1.1.10°. Отслеживание дрейфа экстремума нестационарного функционала

(25).

§ 1.2. Байесовские критерии............................................ 26

1.2.1°. Функционал среднего риска (26). 1.2.2°. Автоматическая класси-

фикация изображений (27). 1.2.3°. Автоматическая классификация при не-

известных апостериорных вероятностях (29) 1.2.4°. Оптимальное обнару-

жение сигнала (31).

§ 1.3. Элементы регрессионного анализа................................. 36

1.3.1°. Наилучшая аппроксимация одной случайной величины с помощью

другой (36). 1.3.2°. Линейная регрессионная модель (38). 1.3.3°. Регрес-

сия в случае гауссовских случайных величин (41). 1.3.4°. Оценивание по

конечному числу наблюдений (42).

§ 1.4. Элементы теории оценивания...................................... 45

1.4.1°. Байесовские оценки (45). 1.4.2°. Оптимальные оценки в симметрич-

ном случае (48). 1.4.3°. Метод максимума правдоподобия (48). 1.4.4°. До-

стижимая точность оценивания (50). 1.4.5°. Метод эмпирического функциона-

ла (53). 1.4.6°. Метод стохастической аппроксимации (55).

§ 1.П. Приложение: некоторые сведения о сходимости случайных величин ... 66

1.П.1°. Последовательности случайных величин, близкие к супермартингалам

(66). 1.П.2°. Закон больших чисел для независимых случайных величин

(66).

§ 1.Д. Доказательства лемм и теорем.................................... $7

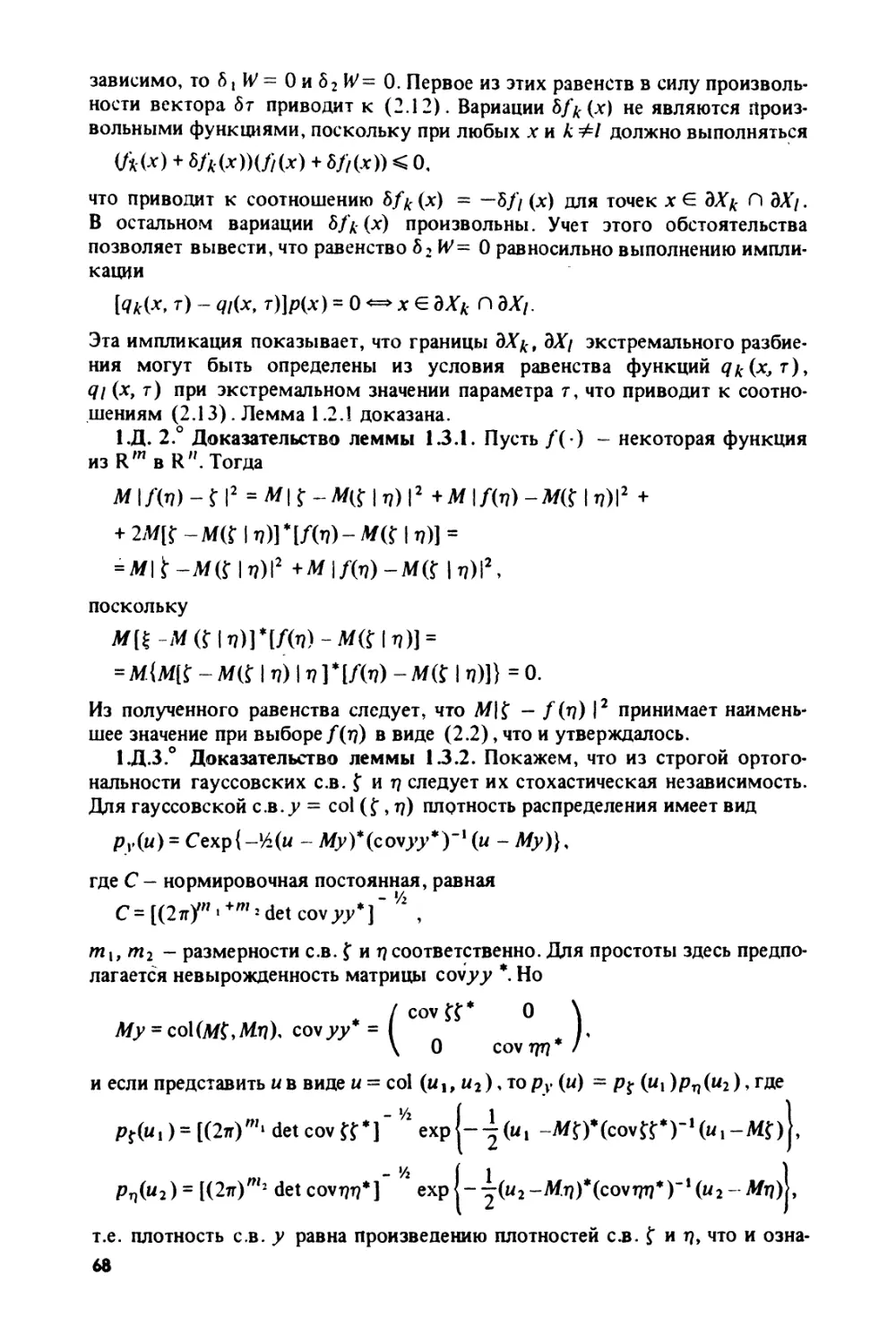

1.Д.1°. Доказательство леммы 1.2.1 (67). 1.Д.2°. Доказательство леммы

1.3.1 (68). 1.Д.З°. Доказательство леммы 1.3.2 (68). 1.Д.4°. Доказатель-

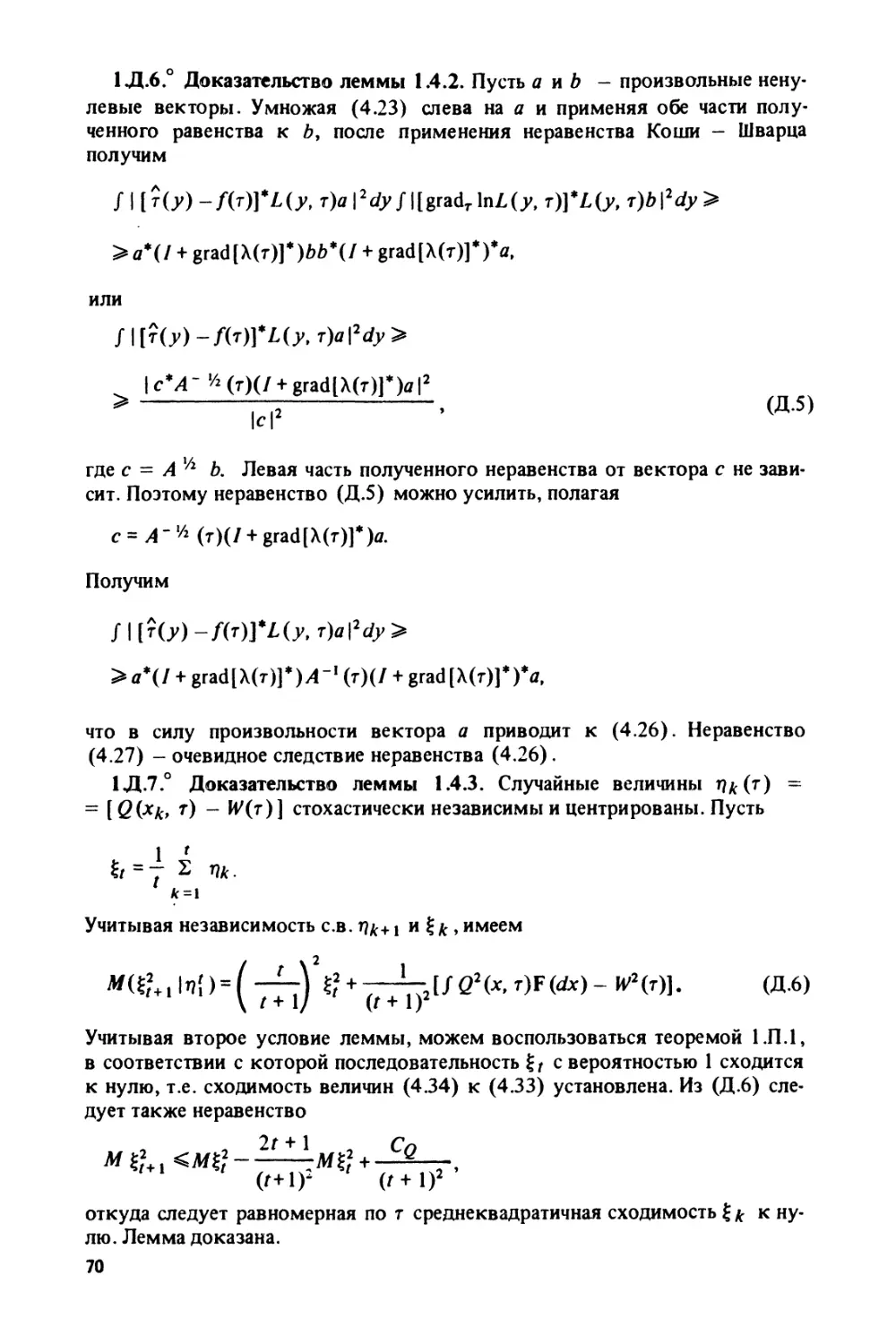

ство леммы 1.3.3 (69). 1. Д.5 °. Доказательство леммы 1.4.1 (69). 1.Д.6°.

Доказательство леммы 1.4.2 (70). 1.Д.7°. Доказательство леммы 1.4.3

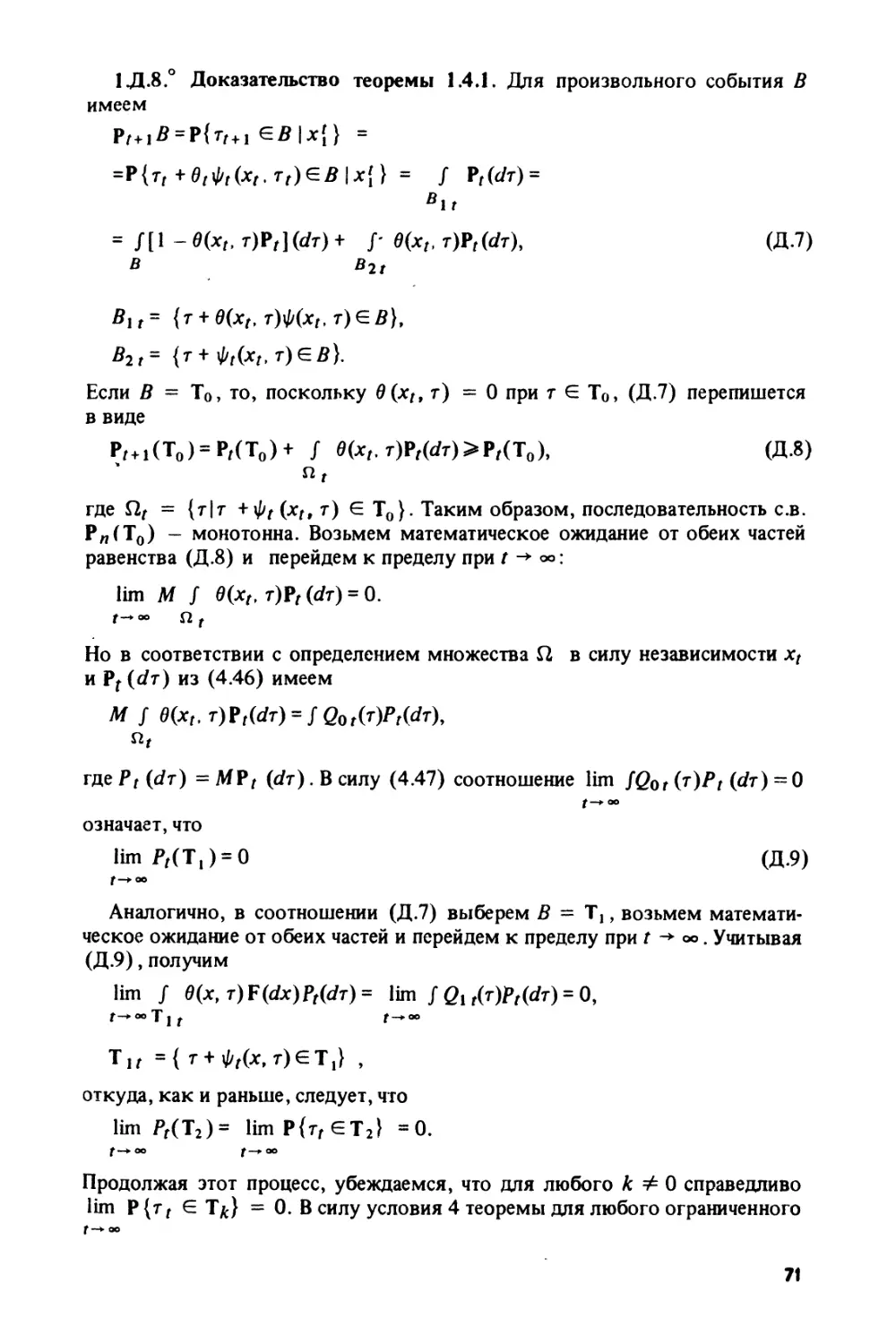

(70). 1.Д.8°. Доказательство теоремы 1.4.1 (71).. 1.Д.9°. Доказательство

теоремы 1.4.2 (72). 1.Д. 10°. Доказательство леммы 1.4.4 (72). 1.Д.110. До-

казательство теоремы 1.4.3 (73). 1.Д. 12°. Доказательство теоремы 1.4.4

(73). 1.Д.13°. Доказательство теоремы 1.4.5 (74).

3

ГЛАВА 2

РЕКУРРЕНТНОЕ ОЦЕНИВАНИЕ В НЕКОТОРЫХ ЗАДАЧАХ ОБУЧЕНИЯ,

ОБНАРУЖЕНИЯ И ИДЕНТИФИКАЦИИ

§ 2.1. Стохастические аналоги конечно-сходящихся алгоритмов в задаче

обучения .......................................................... 77

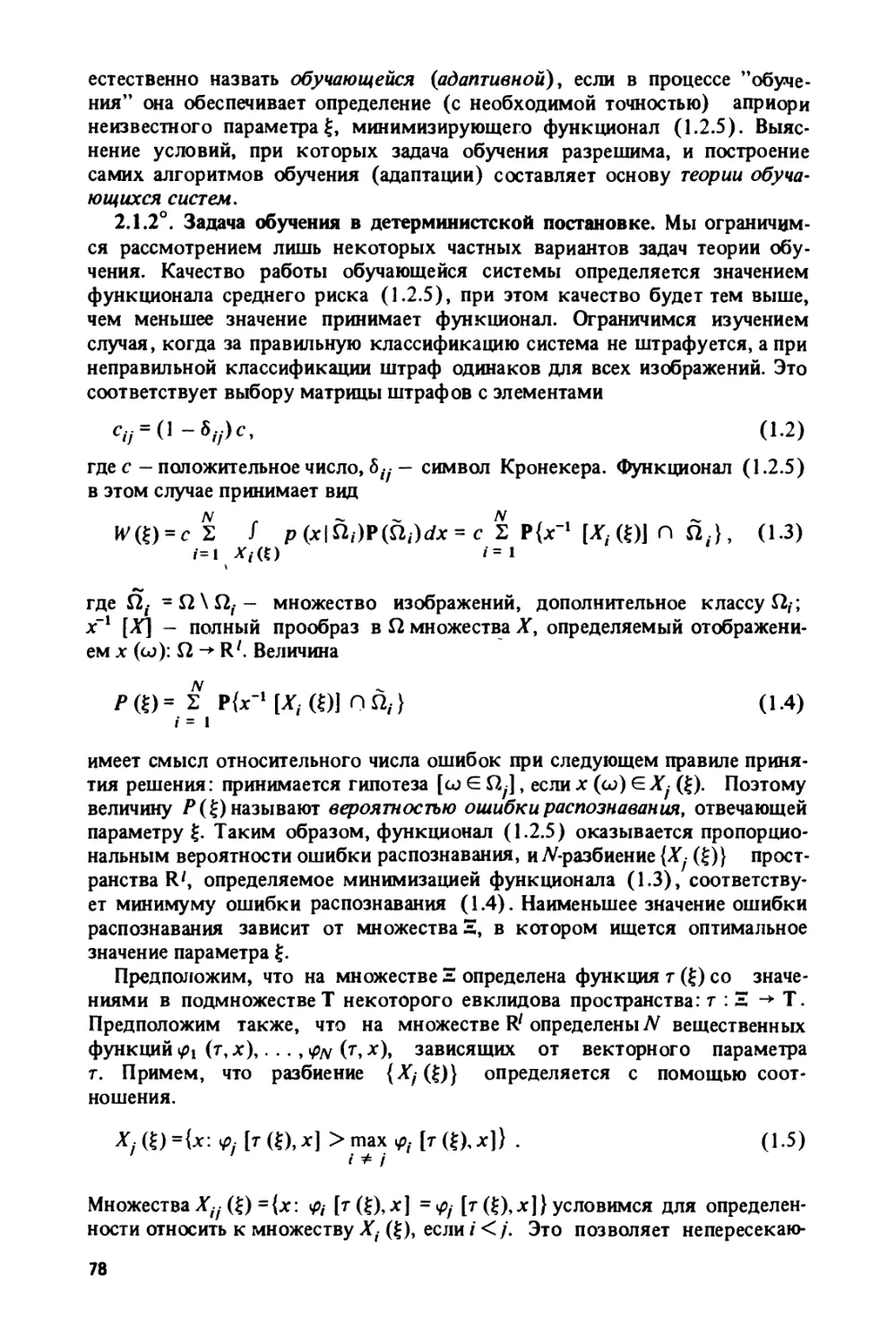

2.1.1°. Постановка задачи обучения распознаванию образов (77). 2.1.2°. За-

дача обучения в детерминистской постановке (78). 2.1.3°. Метод рекур-

рентных целевых неравенств (79). 2.1.4°. Среднее время сходимости ко-

нечно сходящихся алгоритмов (81). 2.1.5°. Алгоритм случайного поиска

с линейной тактикой. Гомеостат Эшби (83). 2.1.6°. Марковские цепи, свя-

занные с конечно-сходящимися процедурами (84). 2.1.7°. Алгоритм вычис-

ления среднего времени сходимости и среднего числа коррекций (87).

2.1.8°. Примеры конечно-сходящихся алгоритмов (89).

§ 2.2. Процедура стохастической аппроксимации в задаче самообучения. 94

2.2.1°. Общие условия сходимости процедуры самообучения (95). 2.2.2°.

Поглощающие множества (96). 2.2.3°. Содержательные свойства поглощаю-

щих множеств (97). 2.2.4°. Свойства процедуры самообучения при наличии

поглощающих множеств (99).

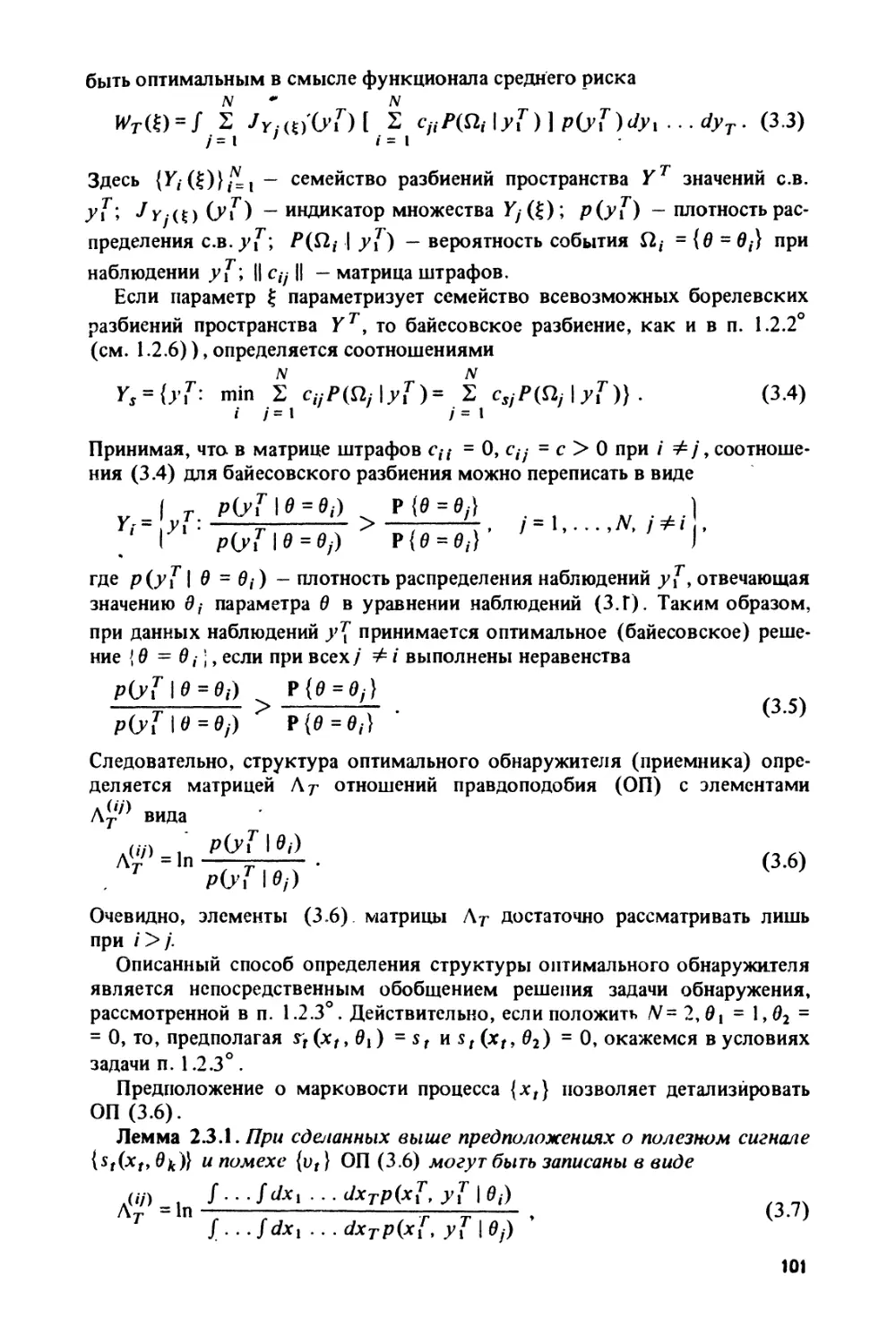

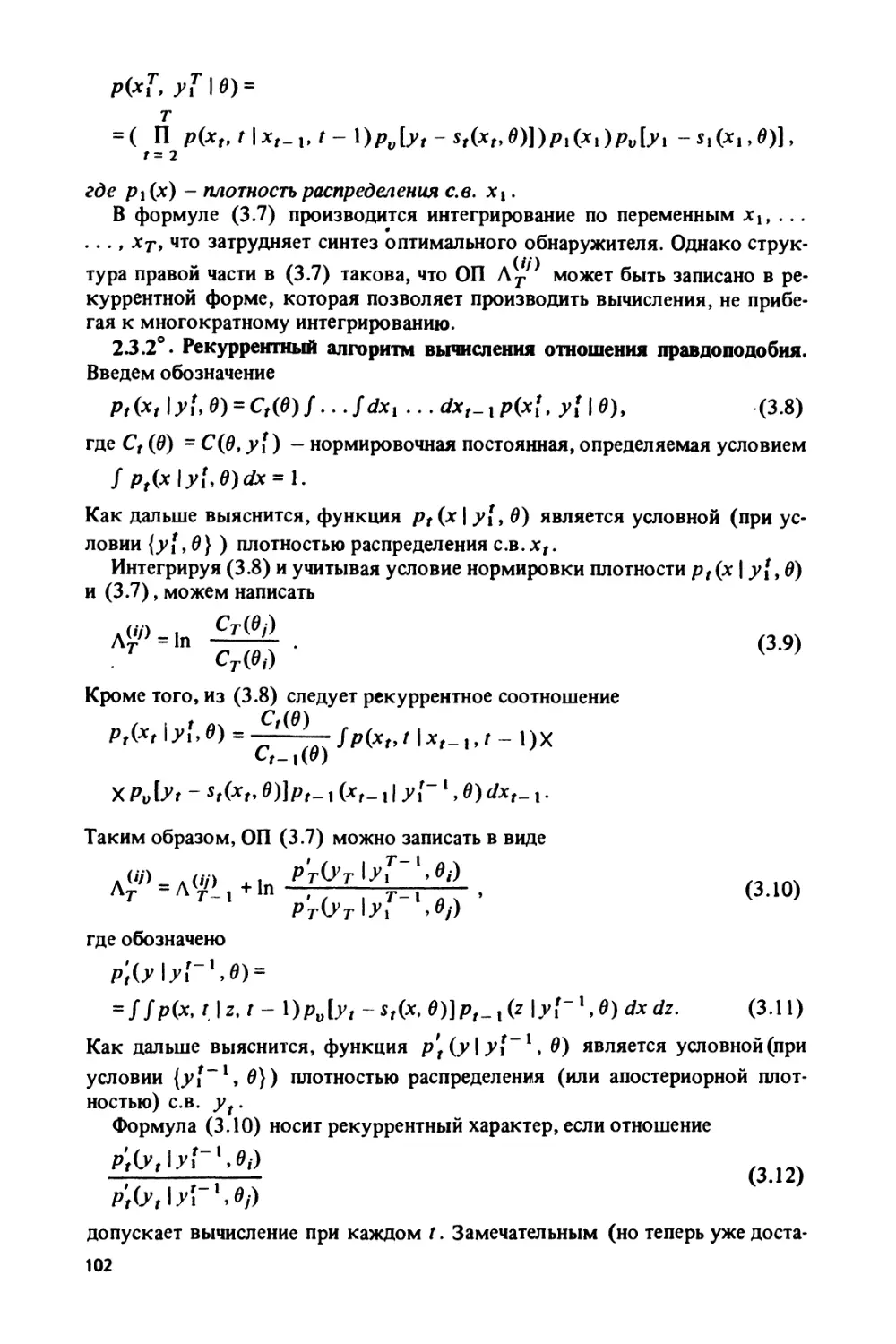

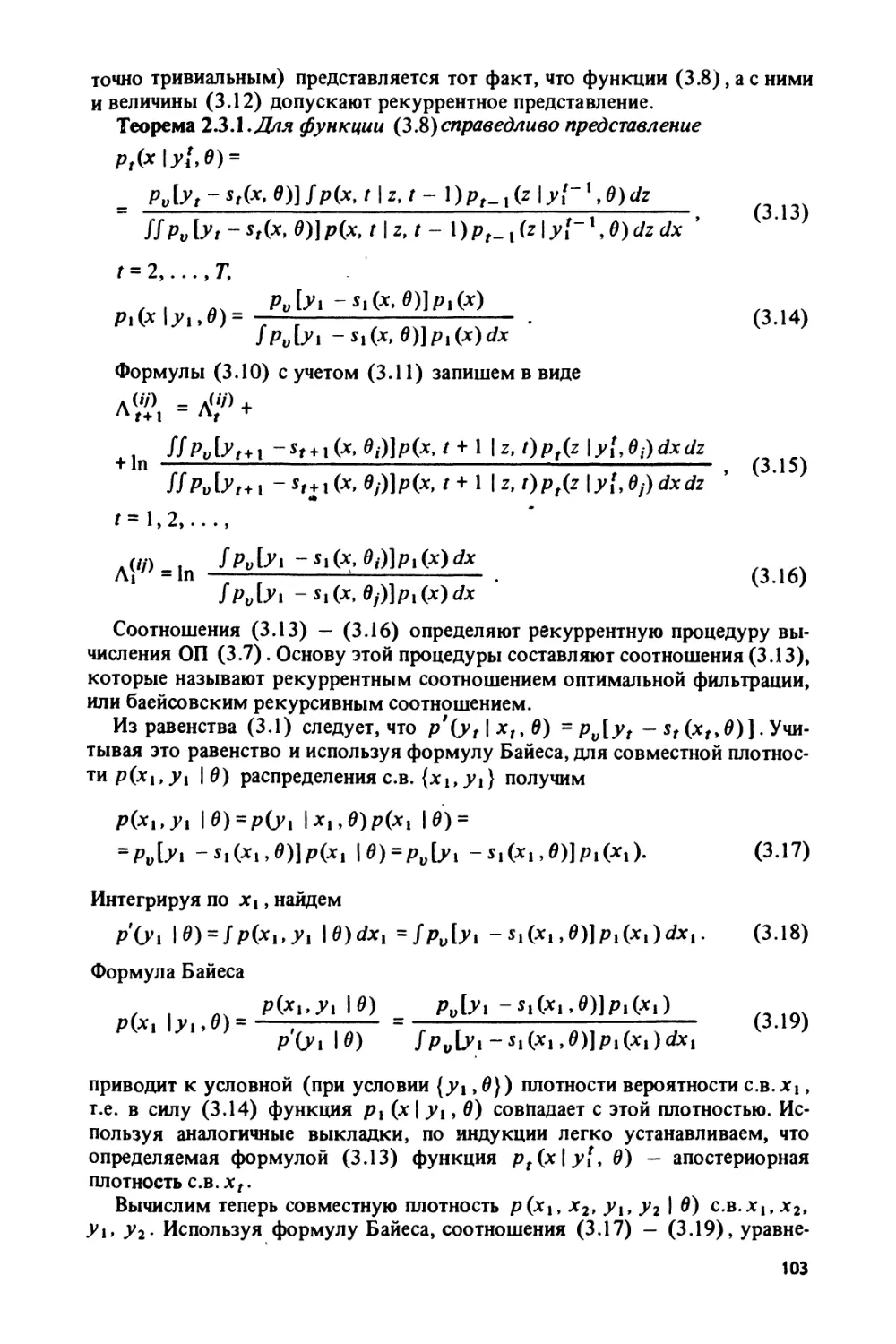

§ 2.3. Рекуррентное байесовское оценивание в задаче обнаружения марков-

ских сигналов....................................................... 100

2.3.1°. Синтез оптимальных систем обнаружения марковских сигналов на фо-

не помехи с независимыми значениями (100). 2.3.2°. Рекуррентный алгоритм

вычисления отношения правдоподобия (102). 2.3.3°. Предельное свойство бай-

есовского обнаружителя (104). 2.3.4°. Оптимальное обнаружение при постоян-

ных параметрах сигнала (107). 2.3.5°. Марковский гауссовский сигнал (111).

§ 2.4. Метод эмпирического функционала в задаче идентификации динамичес-

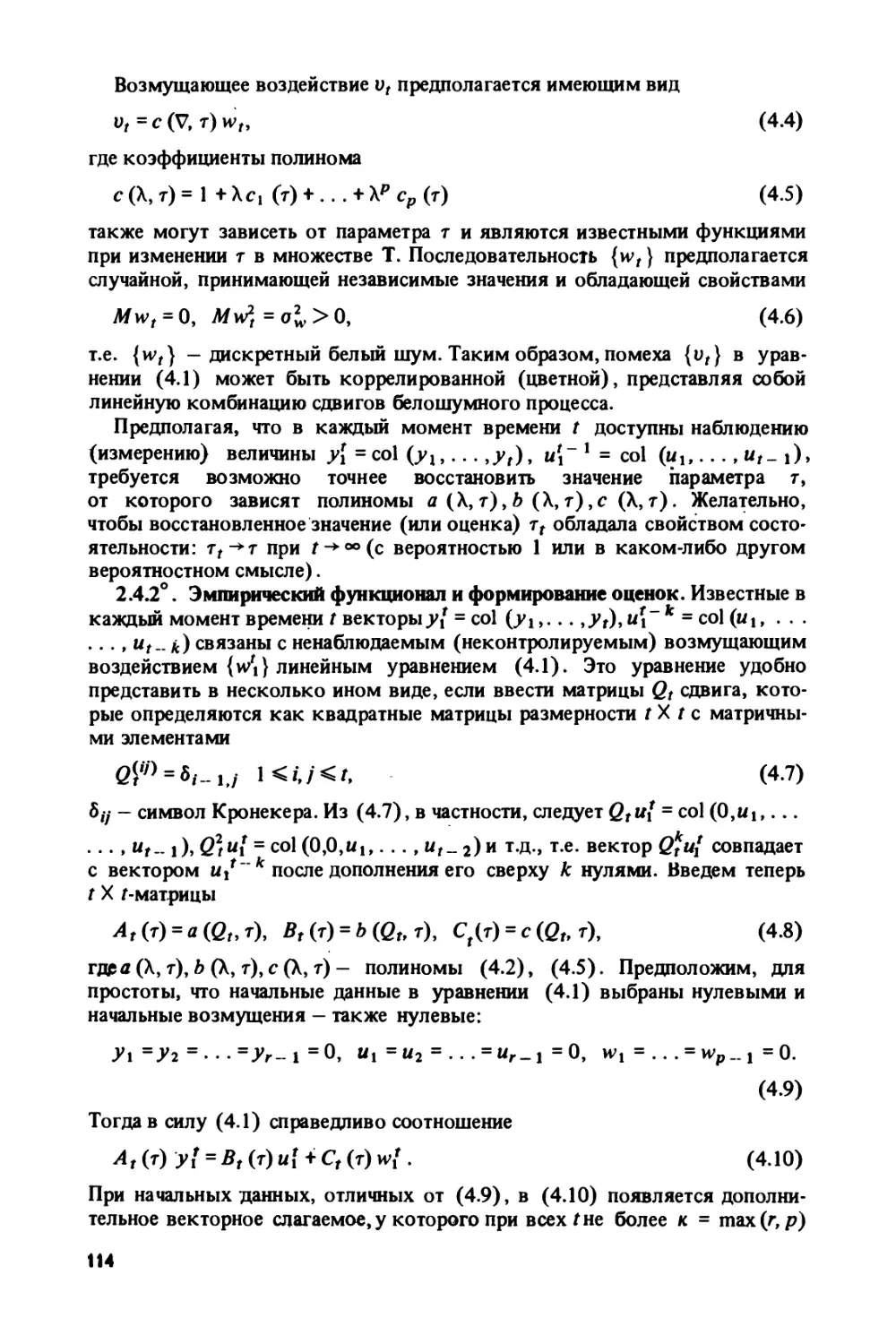

кого объекта, подверженного действию коррелированных возмущений..... 113

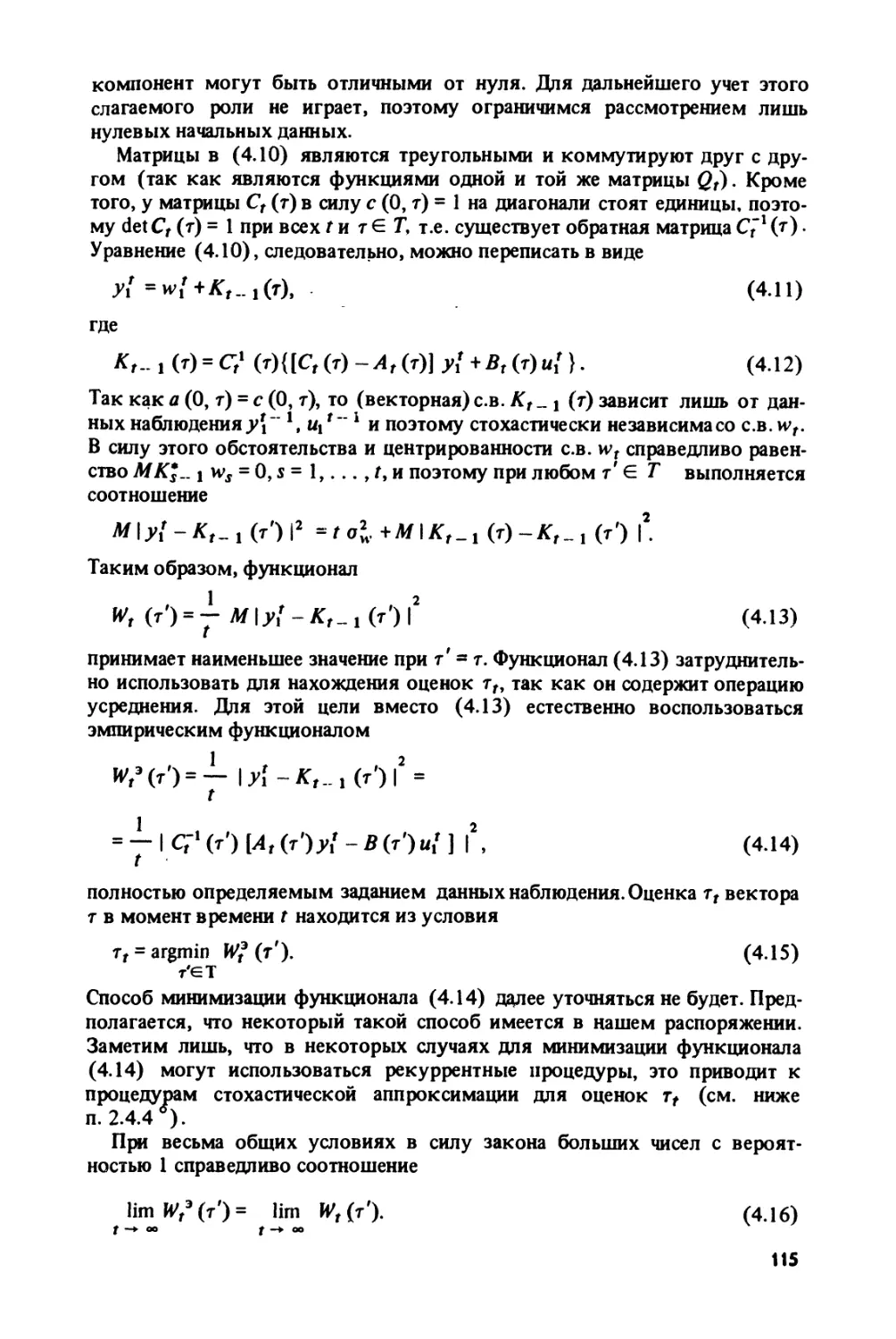

2.4.1°. Постановка задачи идентификации (ИЗ). 2.4.2°. Эмпирический функ-

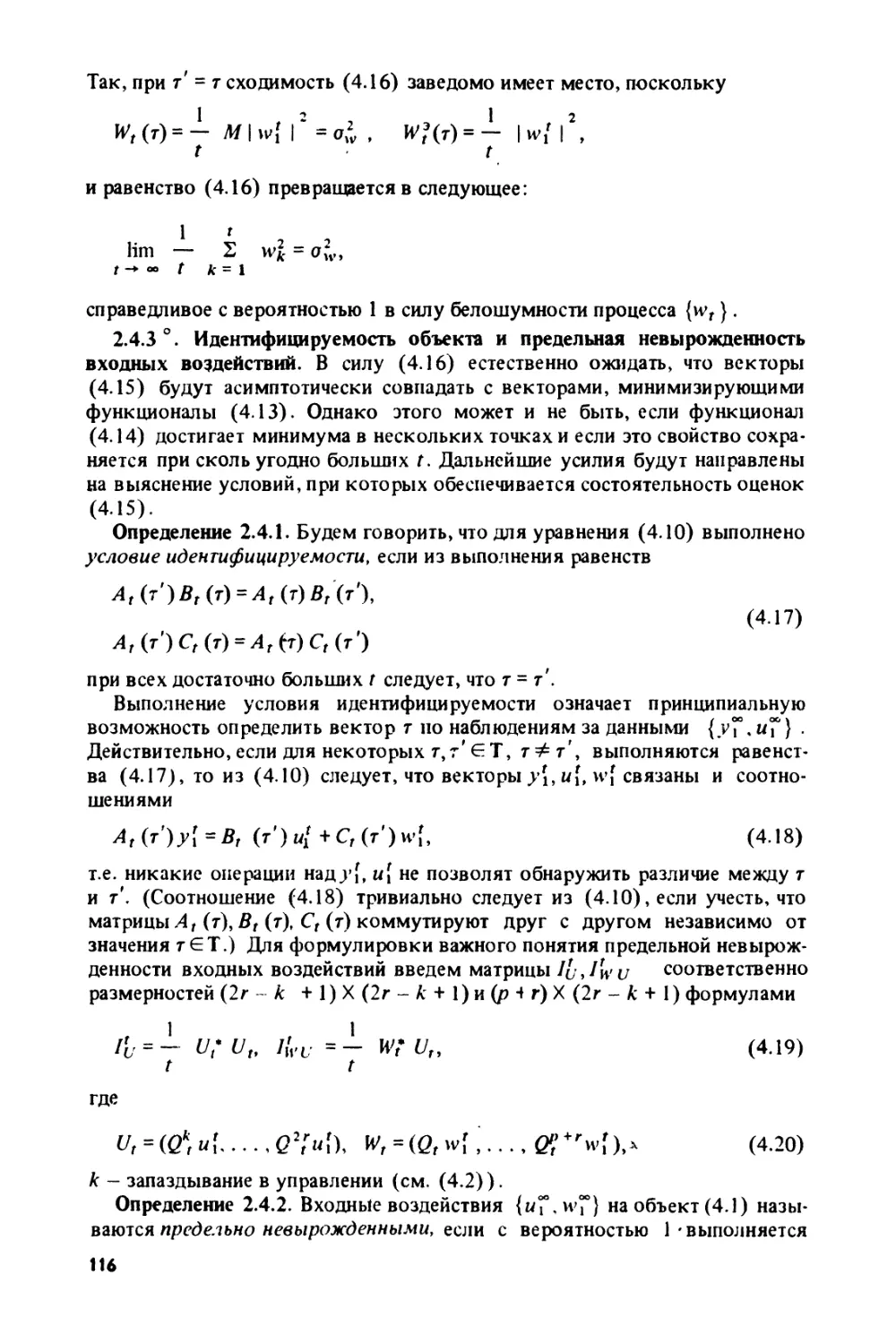

ционал и формирование оценок (114). 2.4.3°. Идентифицируемость объекта и

предельная невырожденность входных воздействий (116). 2.4.4°. Состоятель-

ность оценок, получаемых методом эмпирического функционала (118).

2.4.5°. Обсуждение решения задачи идентификации методом эмпирического

функционала (118).

§ 2.5. Робастное оценивание параметров полезного сигнала............ 123

2.5.1°. Общее понятие о робастном оценивании (123). 2.5.2°. Уточнение схемы

робастного оценивания параметра полезного сигнала (126). 2.5.3°. Критерий

выбора наименее благоприятного распределения (128). 2.5.4°. Класс симмет-

ричных распределений с ограниченной дисперсией (129). 2.5.5°. Линейная за-

висимость полезного сигнала от параметра (130). 2.5.6°. Учет априорной ин-

формации о распределении параметра полезного сигнала (132). 2.5.7°. Описа-

ние некоторых классов робастности (134). 2.5.8°. Рекуррентные процедуры

построения робастных оценок (137).

§ 2.П. Приложение: некоторые сведения о марковских процессах............ 147

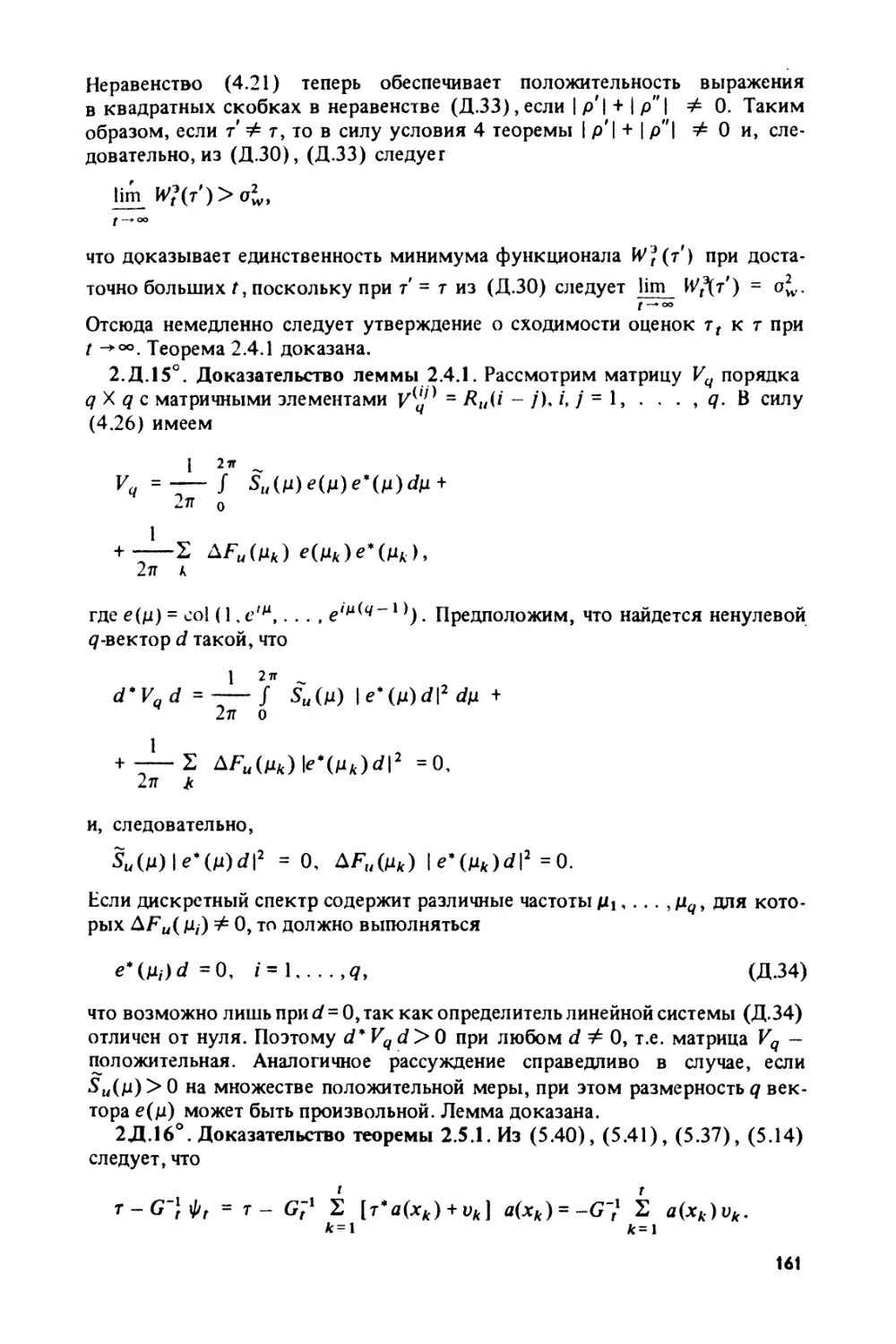

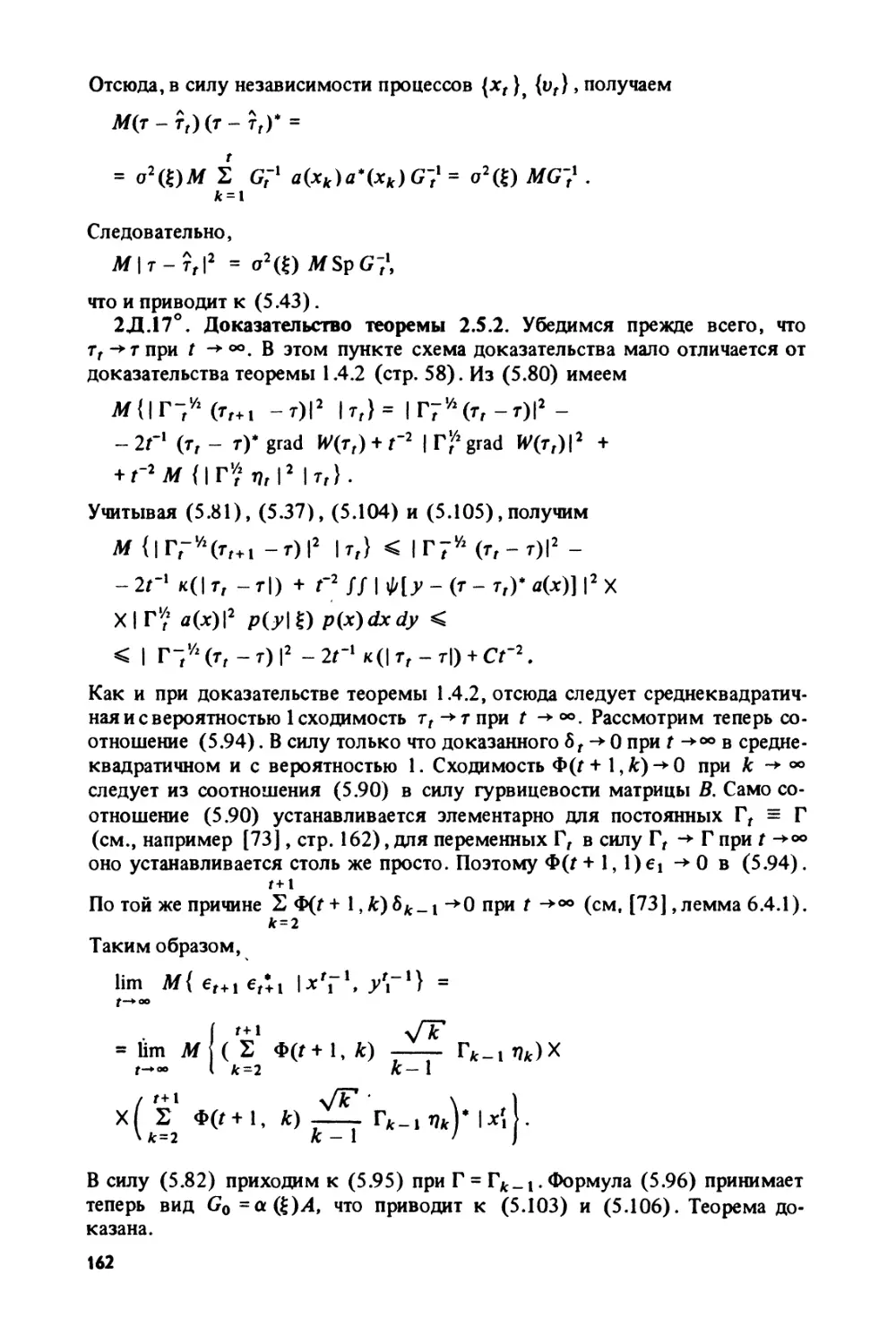

§ 2.Д. Доказательства лемм и теорем................................... 148

2.Д.1°. Доказательство леммы 2.1.1 (148). 2.Д.2°. Доказательство теоремы

2.1.1 (148). 2.Д.З°. Доказательство теоремы 2.1.2 (148). 2.Д.4°. Доказатель-

ство теоремы 2.1.3 (149). 2.Д.5°. Доказательство теоремы 2.2.1 (150).

2.Д.6°. Доказательство леммы 2.2.1 (152). 2.Д.7°. Доказательство теоремы

2.2.2 (152). 2.Д.8°. Доказательство леммы 2.2.2 (153). 2.Д.9°. Доказатель-

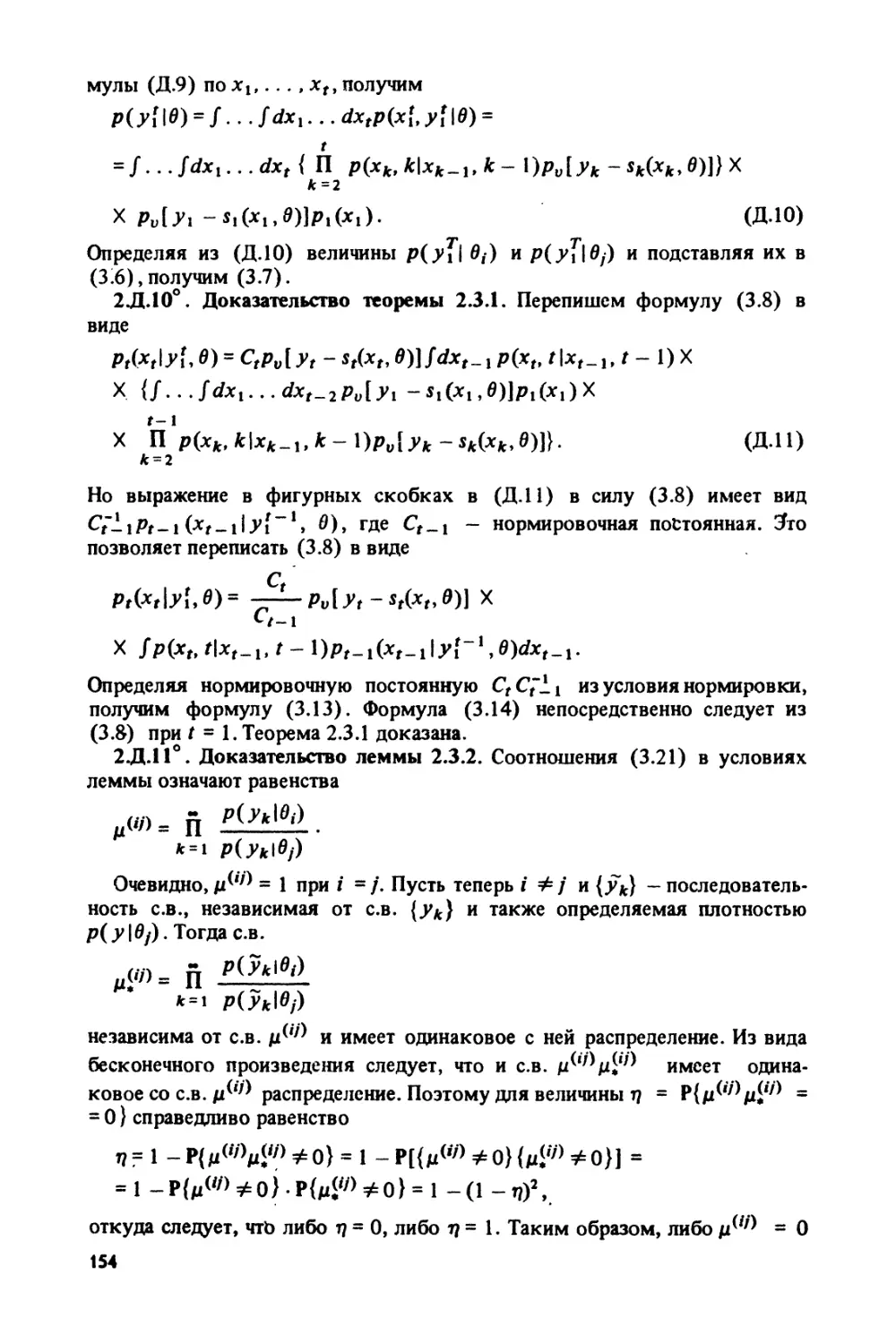

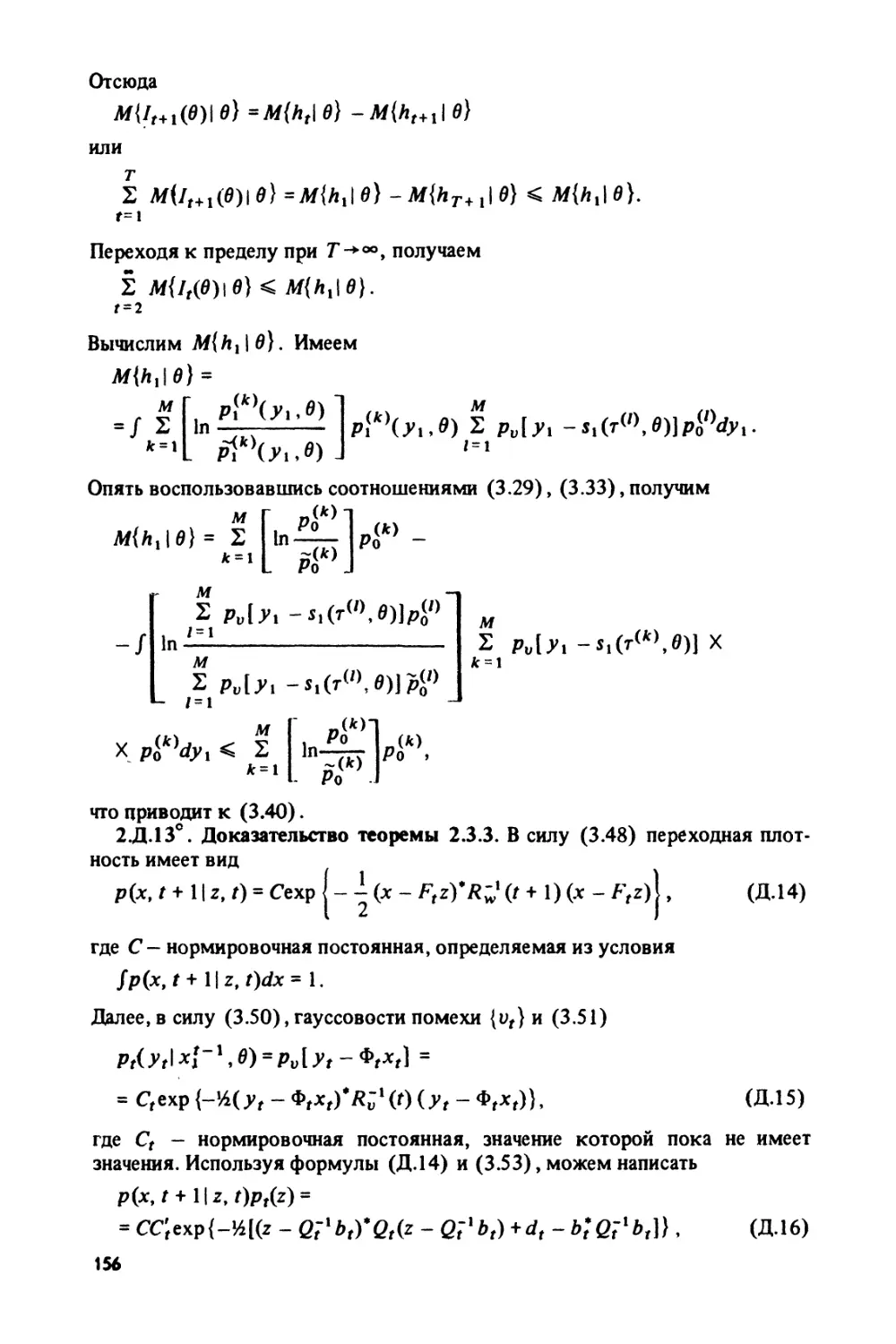

ство леммы 2.3.1 (153). 2.Д.100. Доказательство теоремы 2.3.1 (154). 2.Д.110.

Доказательство леммы 2.3.2 (154). 2.Д.120. Доказательство теоремы 2.3.2

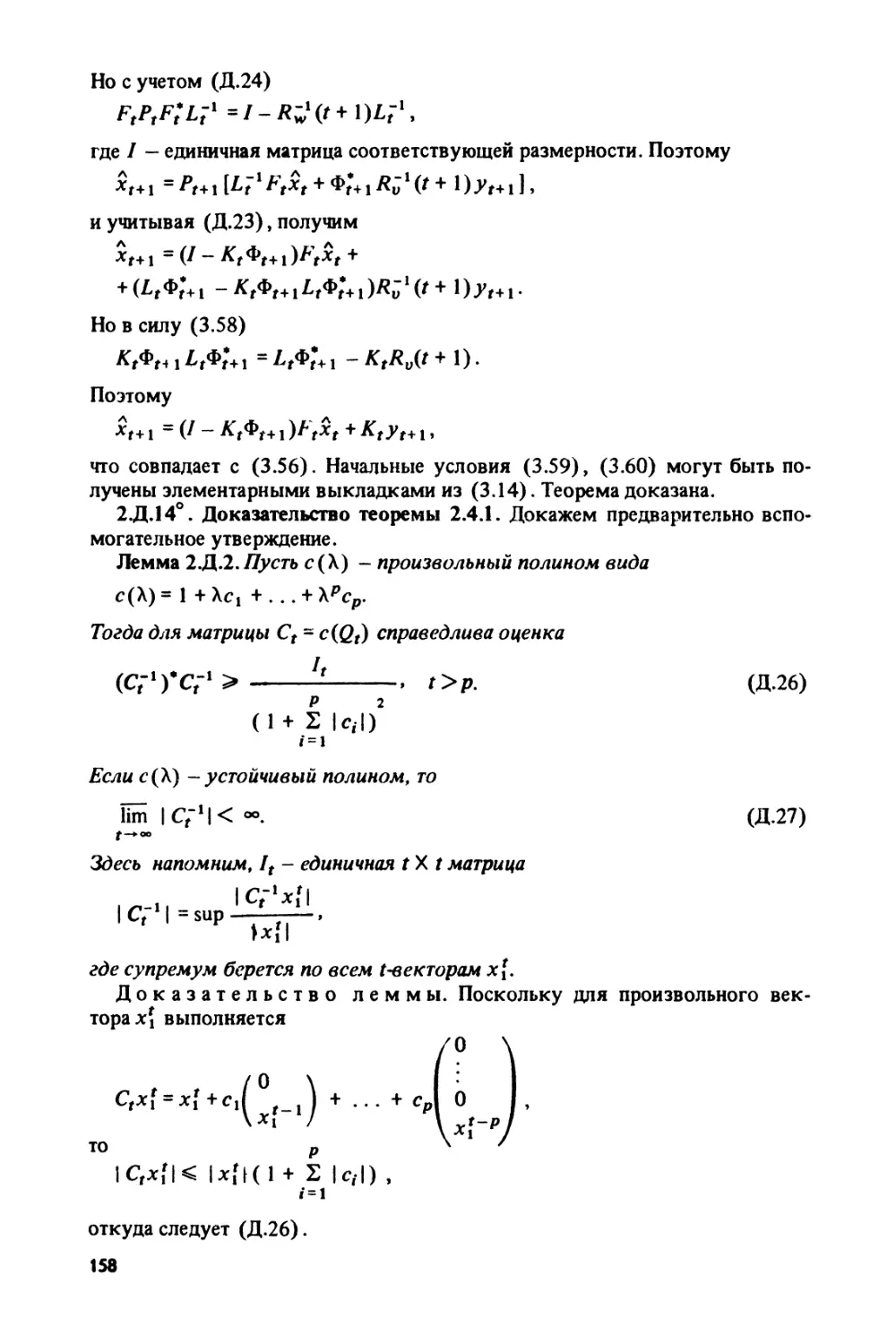

(155). 2.Д.130. Доказательство теоремы 2.3.3 (156). 2.Д. 14°. Доказательство

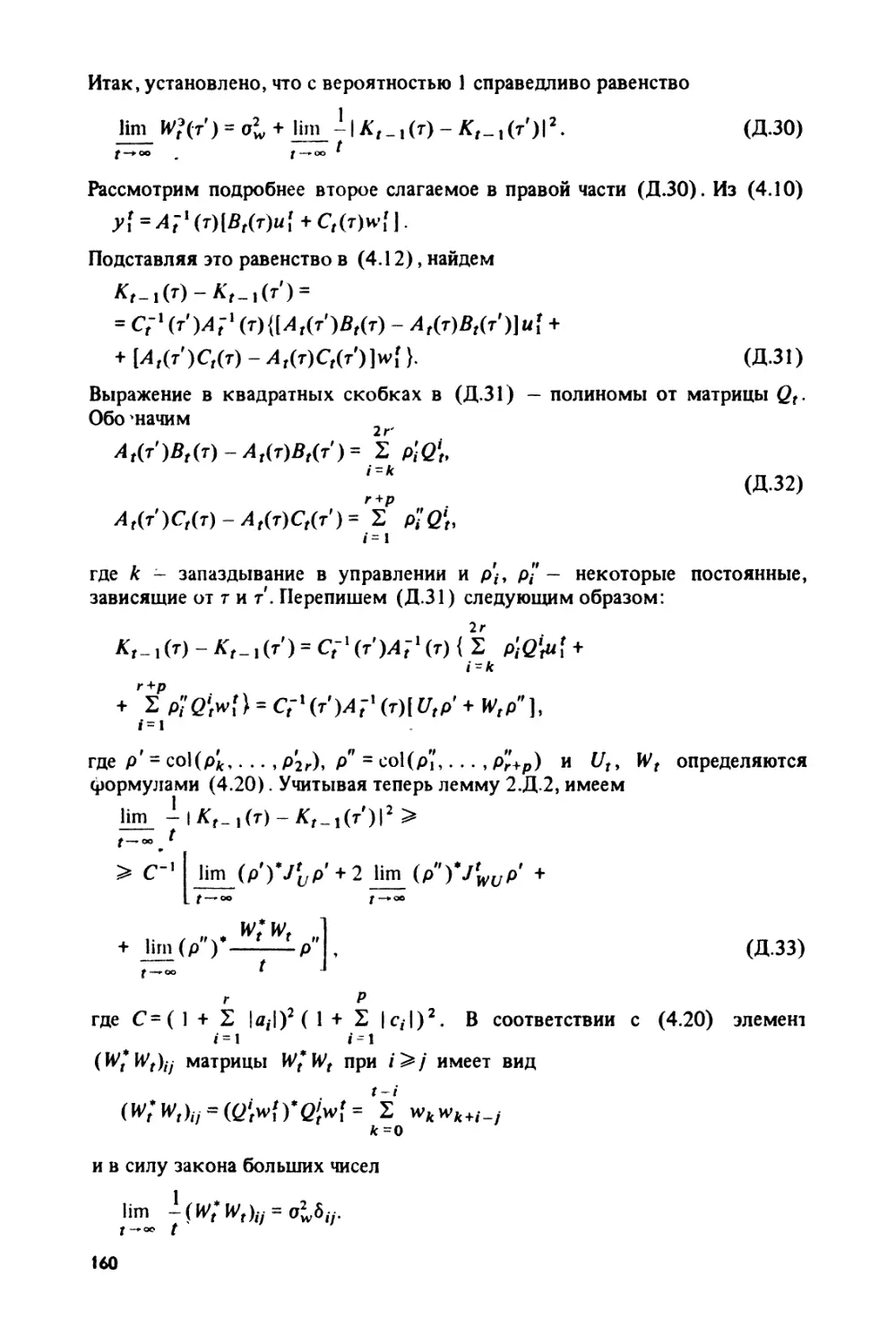

теоремы2.4.1 (158). 2.Д.15°. Доказательство леммы 2.4.1 (161). 2.Д. 16°. До-

казательство теоремы 2.5.1 (161). 2.Д.17°. Доказательство теоремы 2.5.2

(162). 2.Д.18°. Доказательство леммы 2.5.1 (163).

4

ГЛАВА 3

ОПТИМАЛЬНАЯ ФИЛЬТРАЦИЯ СЛУЧАЙНЫХ ПРОЦЕССОВ

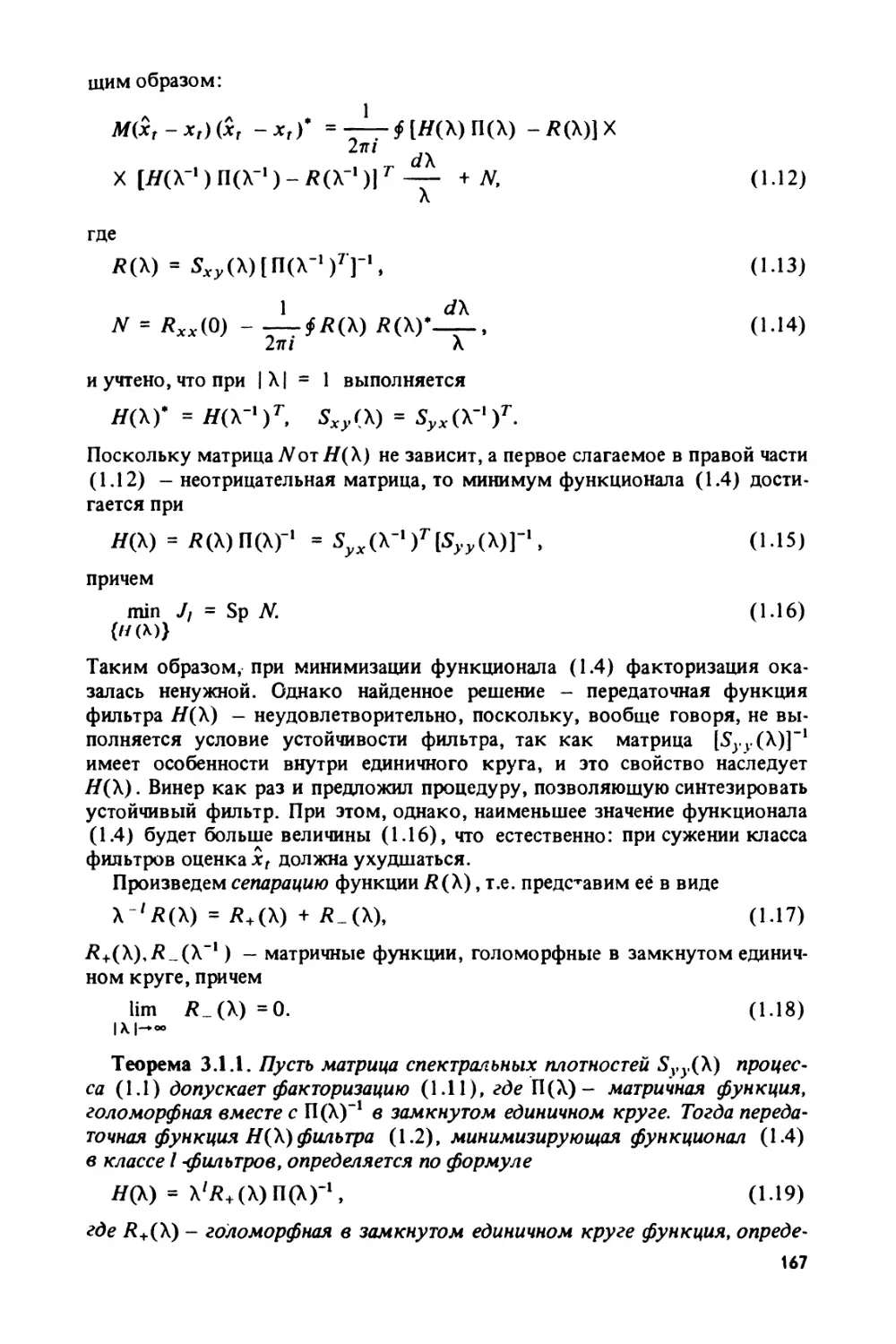

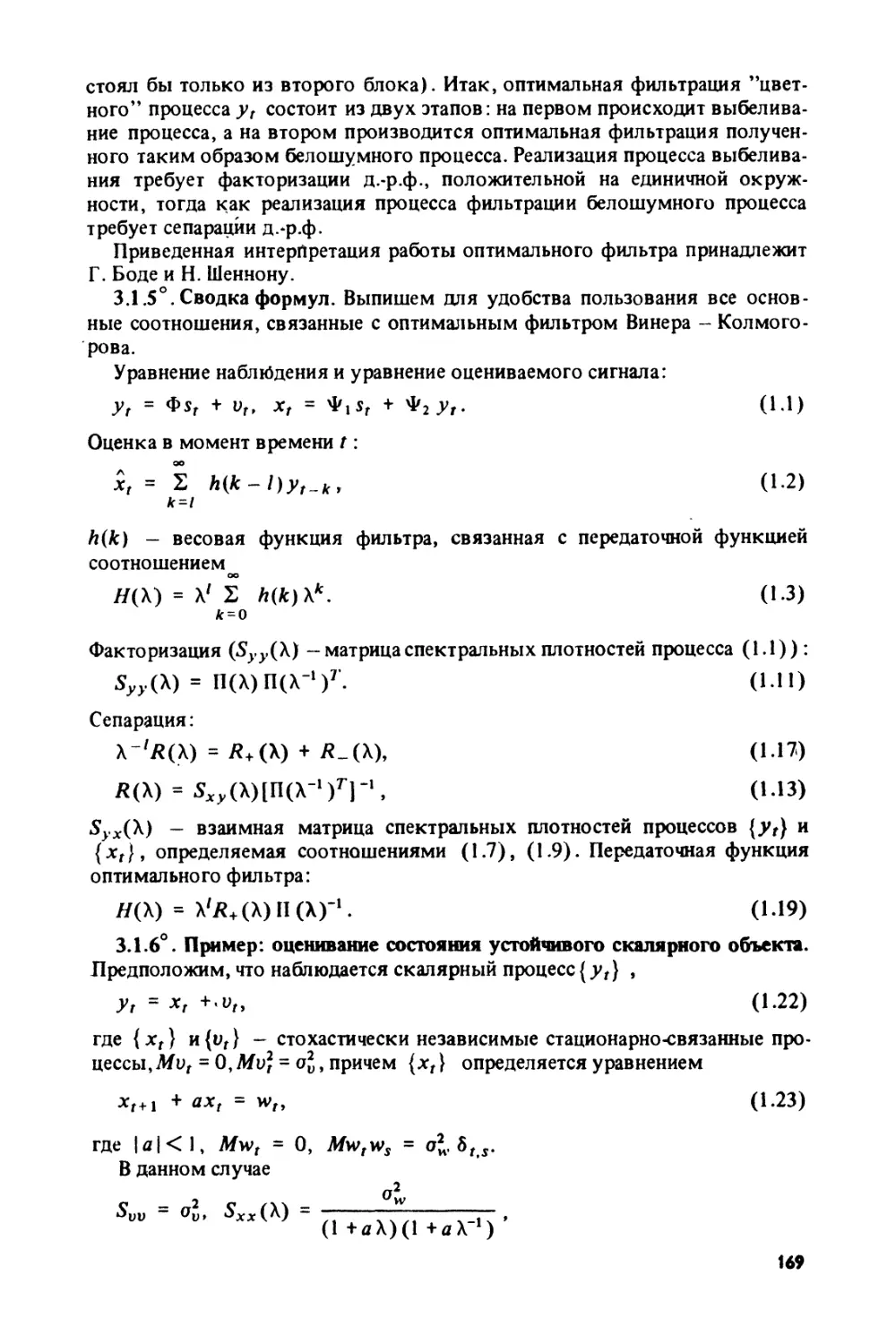

§ 3.1. Фильтр Винера-Колмогорова.................................... 164

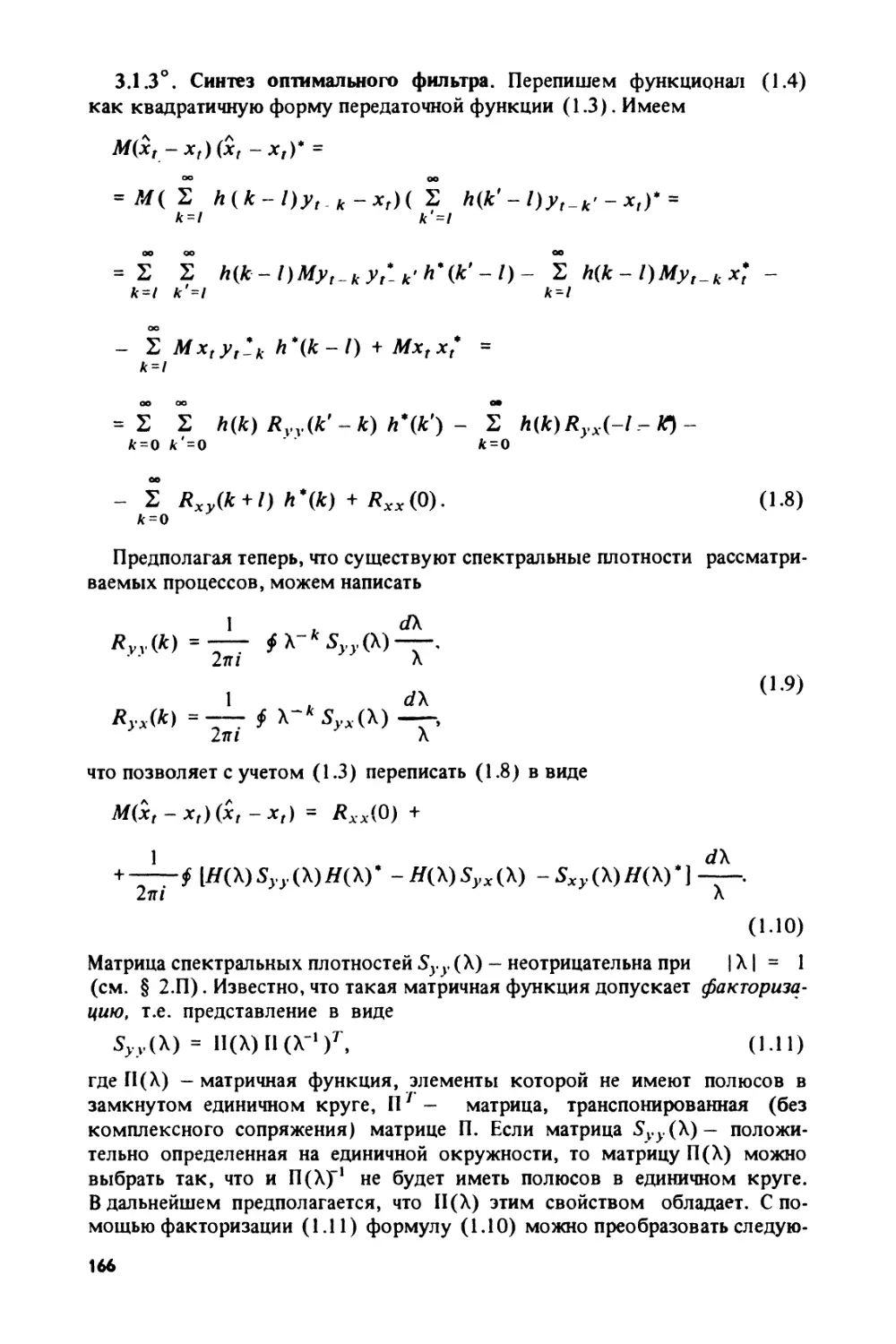

3.1.1°. Постановка задачи (164). 3.1.2°. Уравнение Винера-Хопфа (165).

3.1.3°. Синтез оптимального фильтра (166) 3.1.4°. Интерпретация действия

оптимального устойчивого фильтра (168). 3.1.5°. Сводка формул (169).

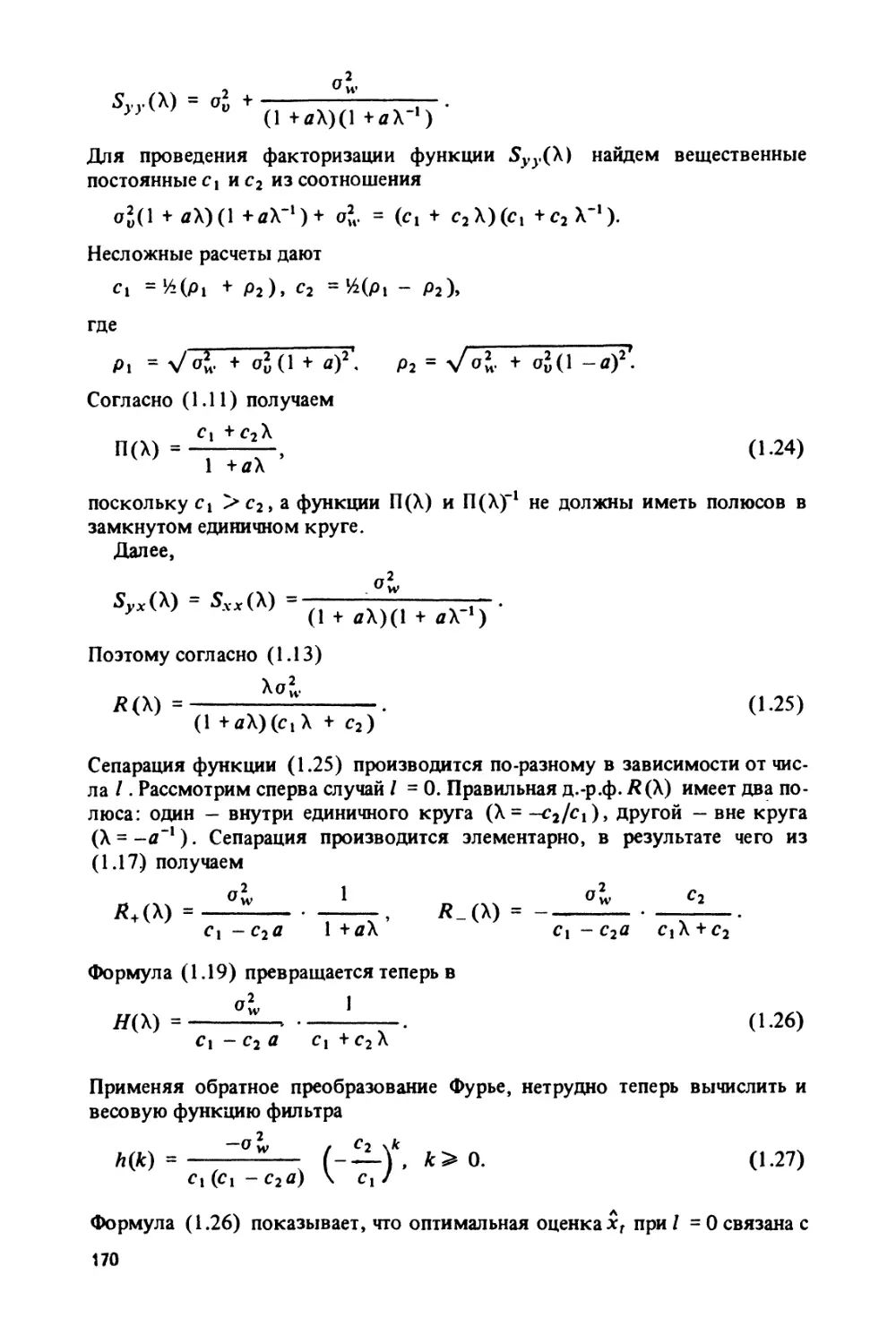

3.1.6°. Пример: оценивание состояния устойчивого скалярного объекта (169).

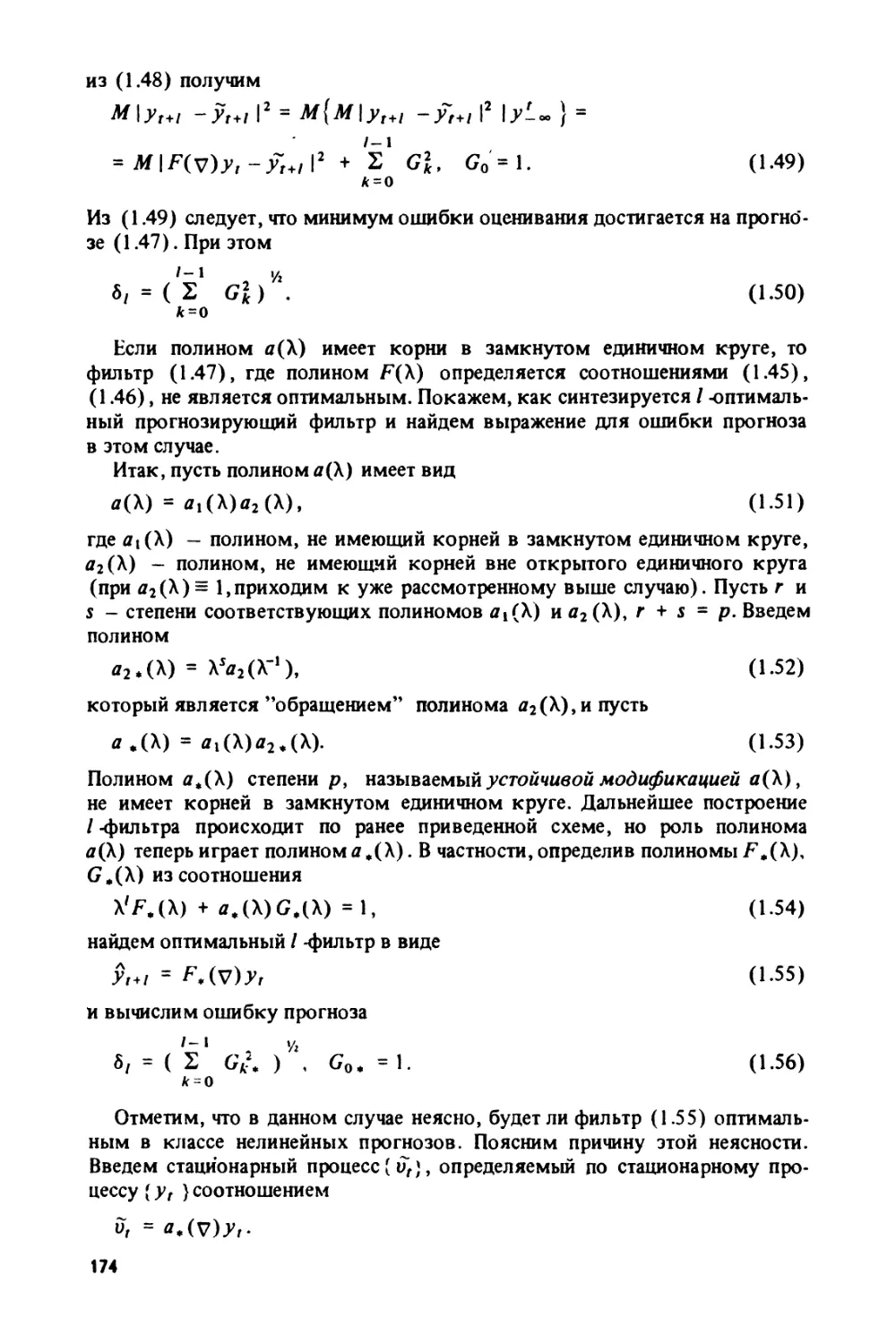

3.1.7°. Пример: оптимальный прогноз значения авторегрессионного процесса

(173). 3.1.8°. Синтез оптимальных следящих систем (175). 3.1.9°. Устойчи-

вый линейный фильтр, максимизирующий отношение сигнал/шум (177).

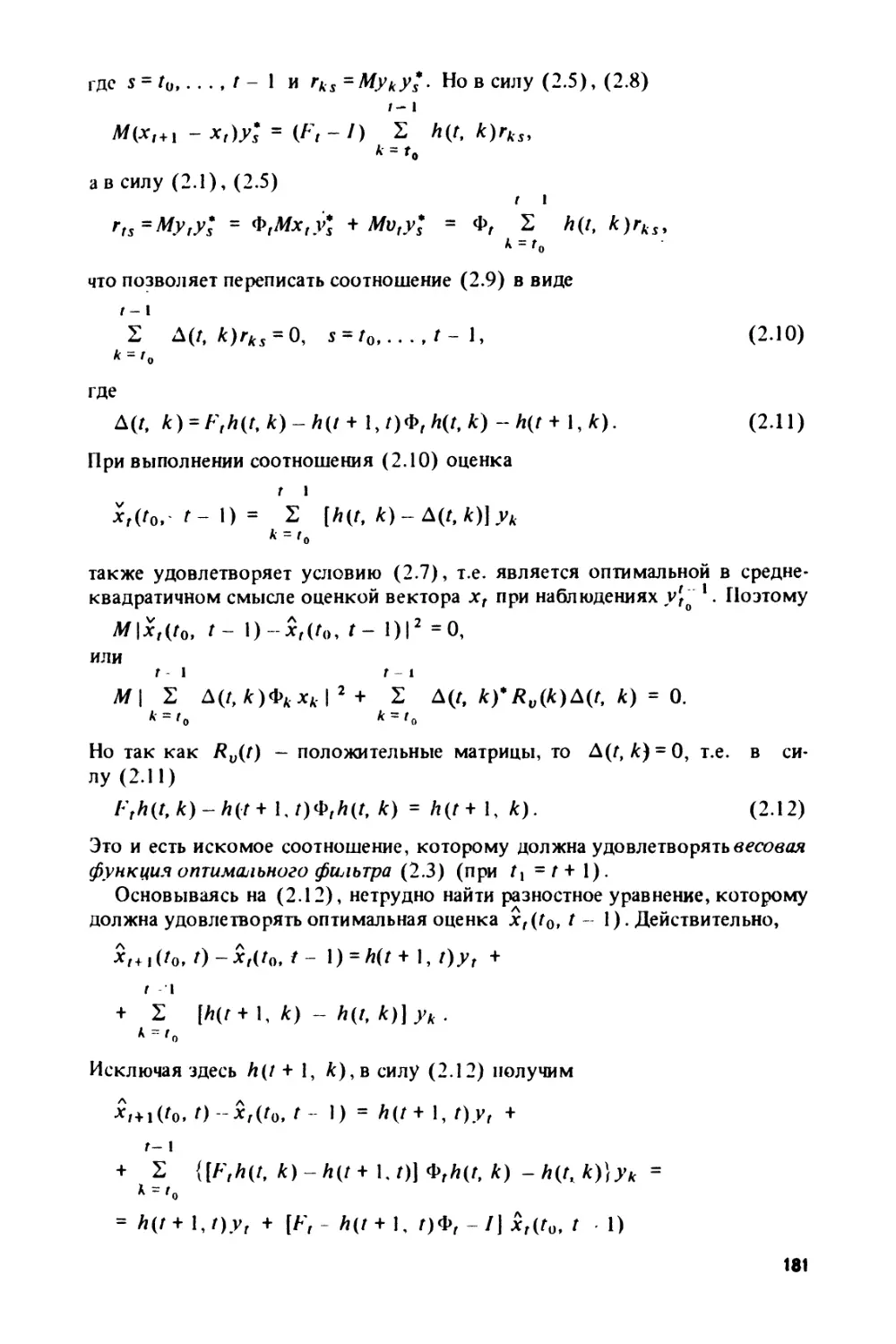

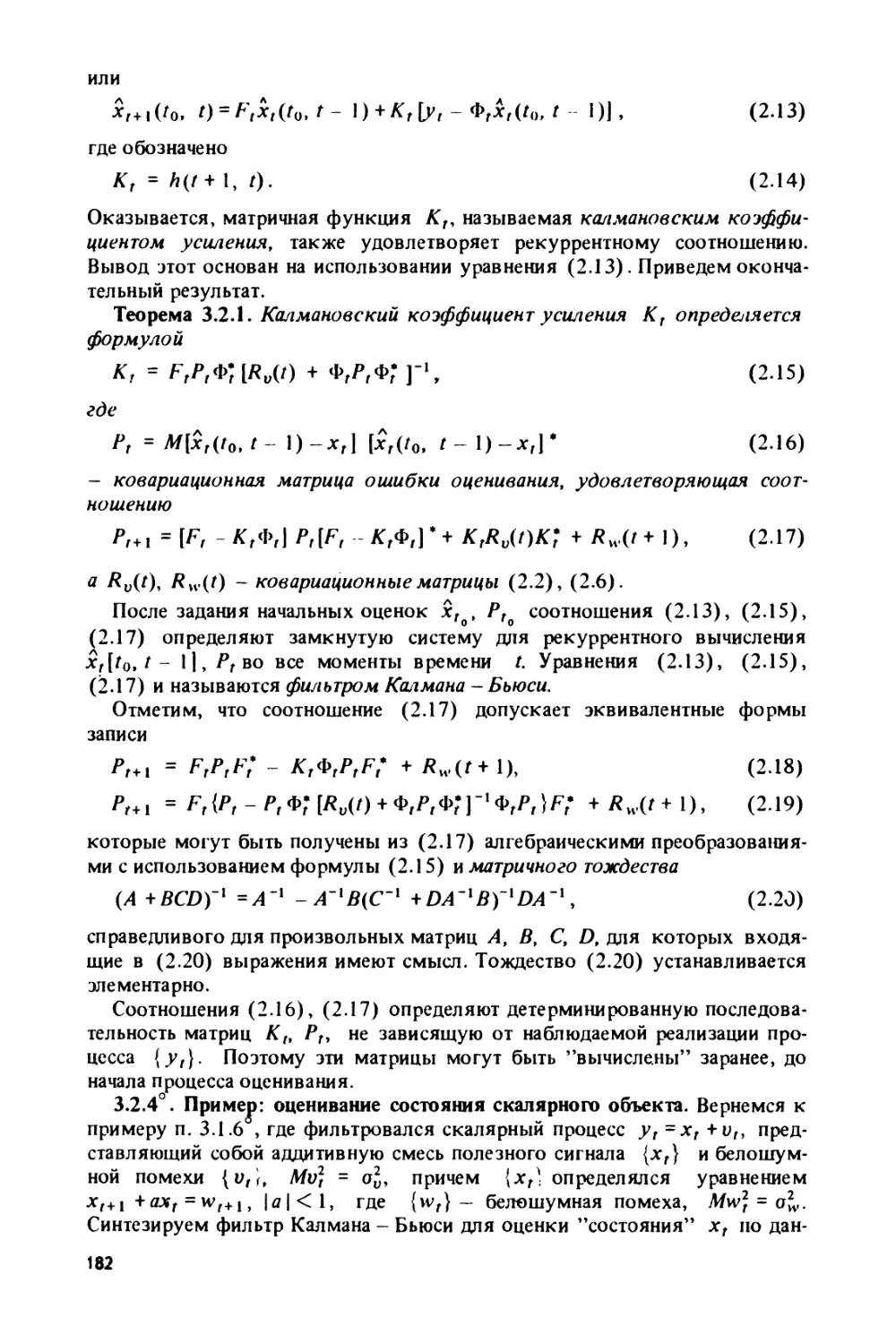

§ 3.2. Фильтр Калмана-Бьюси......................................... 179

3.2.1°. Постановка задачи (179). 3.2.2°. Нестационарное уравнение Винера-

Хопфа (180). 3.2.3°. Каноническая форма оптимального фильтра (180).

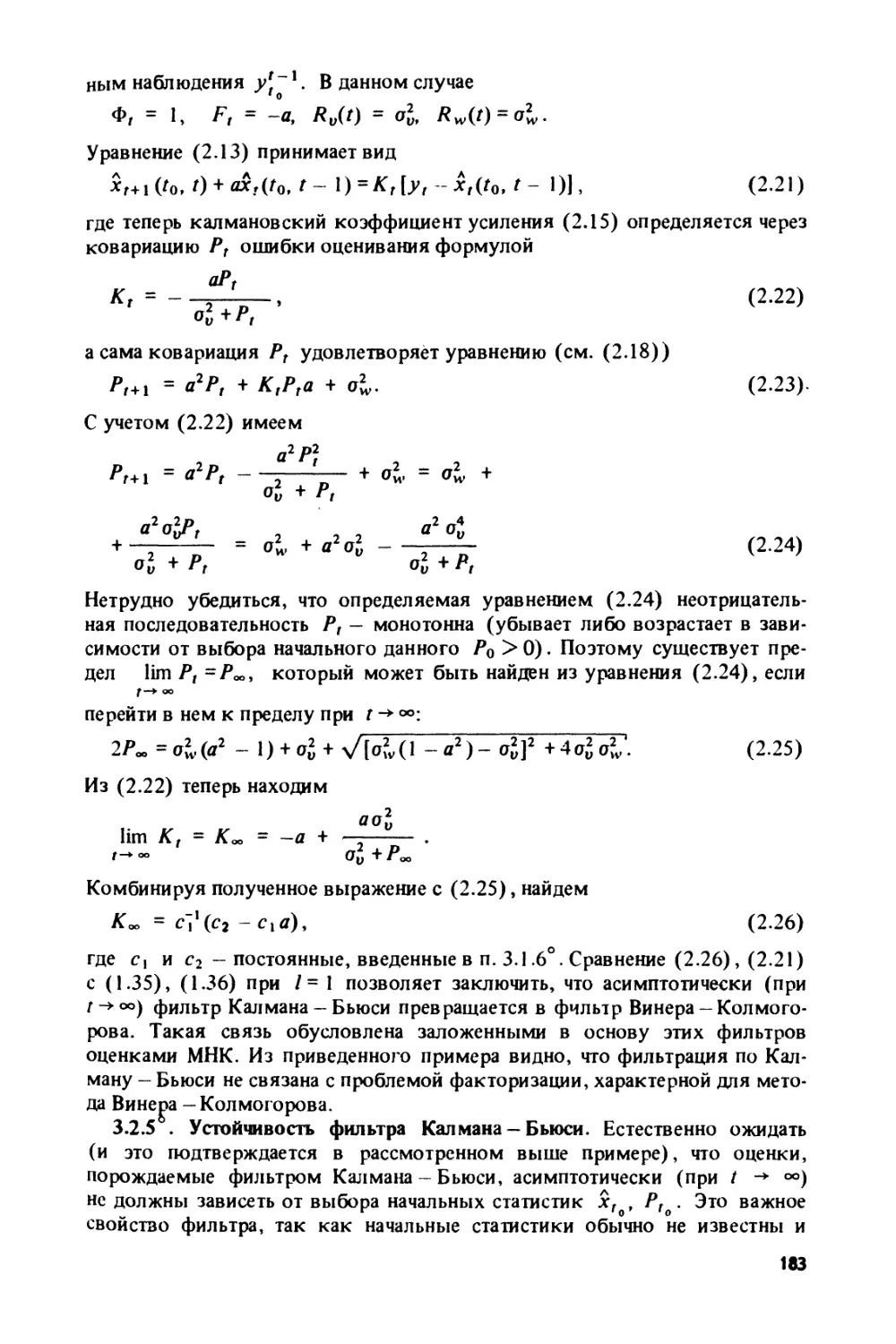

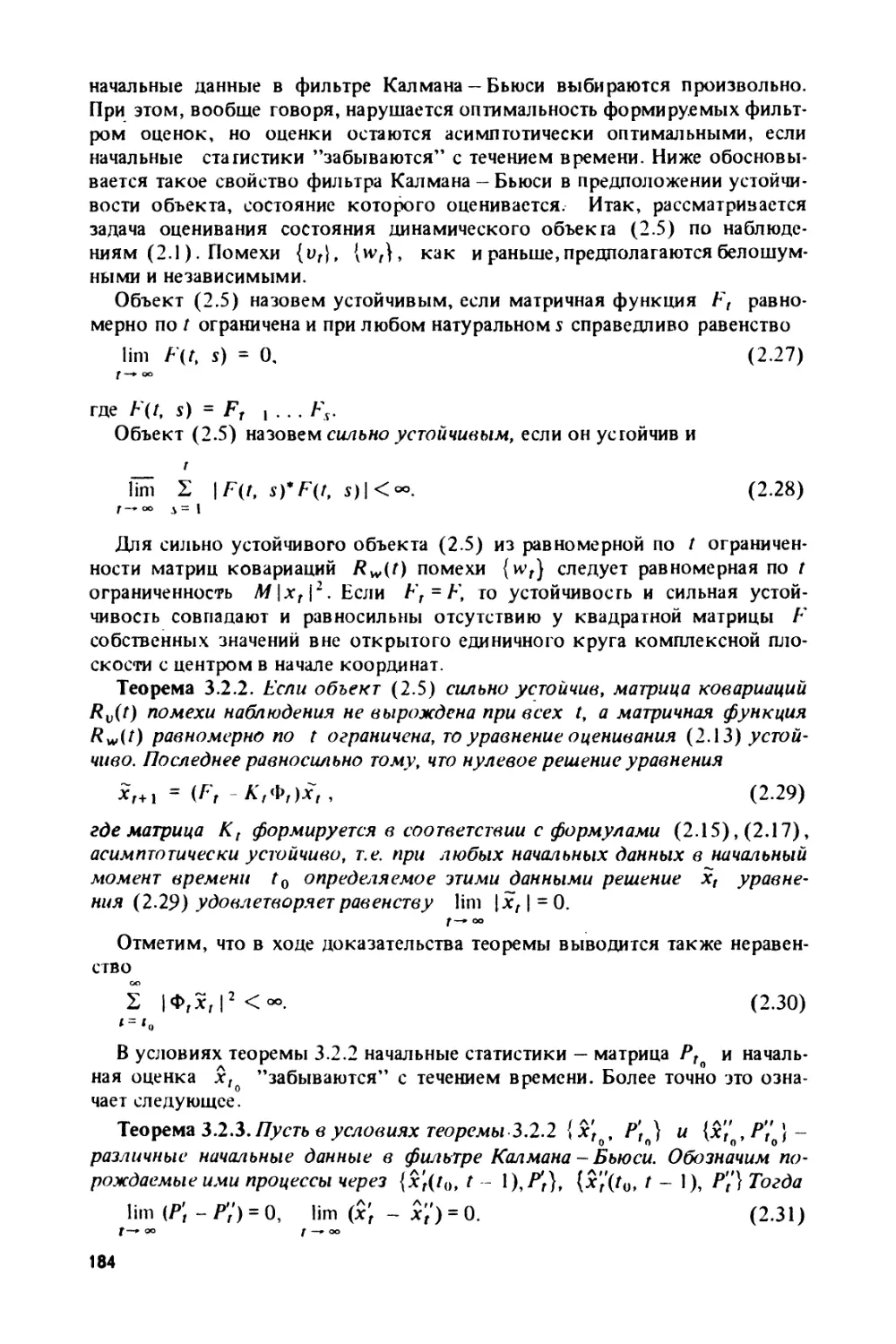

3.2.4°. Пример: оценивание состояния скалярного объекта (182). 3.2.5°. Ус-

тойчивость фильтра Калмана-Бьюси (183). 3.2.6°. Фильтр Калмана-Бьюси

в стационарном случае (185). 3.2.7°. Фильтр Калмана-Бьюси в задаче отсле-

живания дрейфа параметров динамического объекта (186).

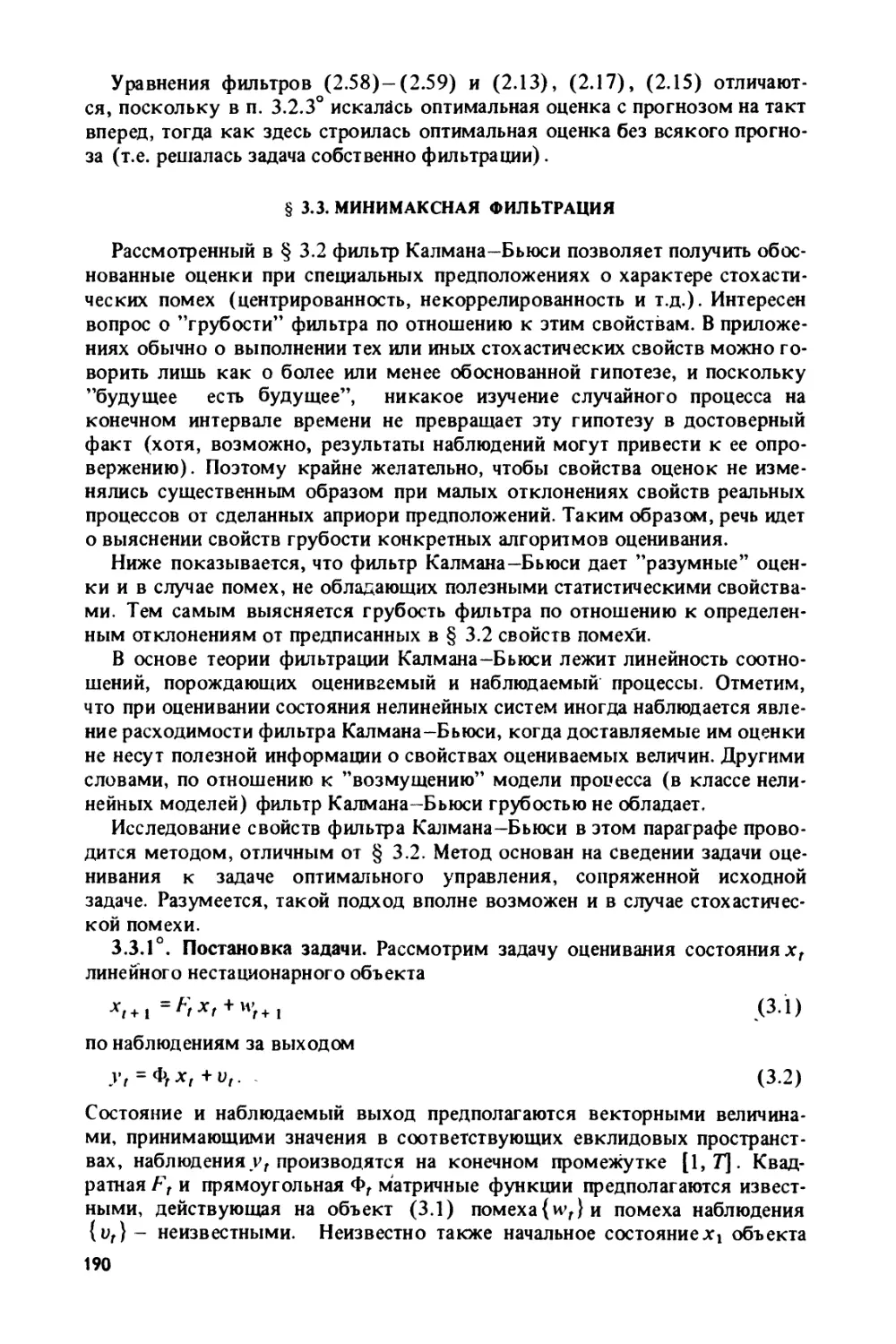

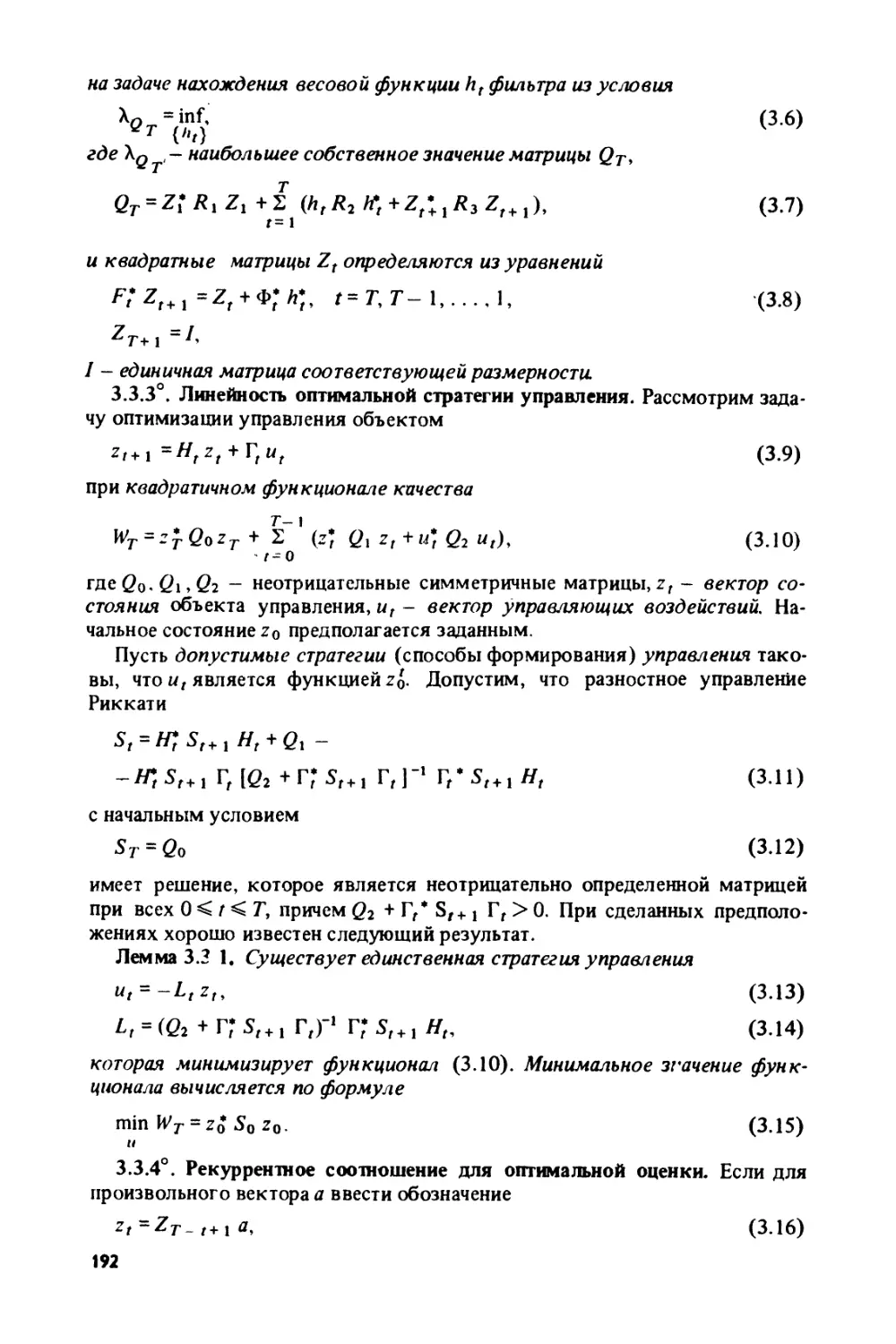

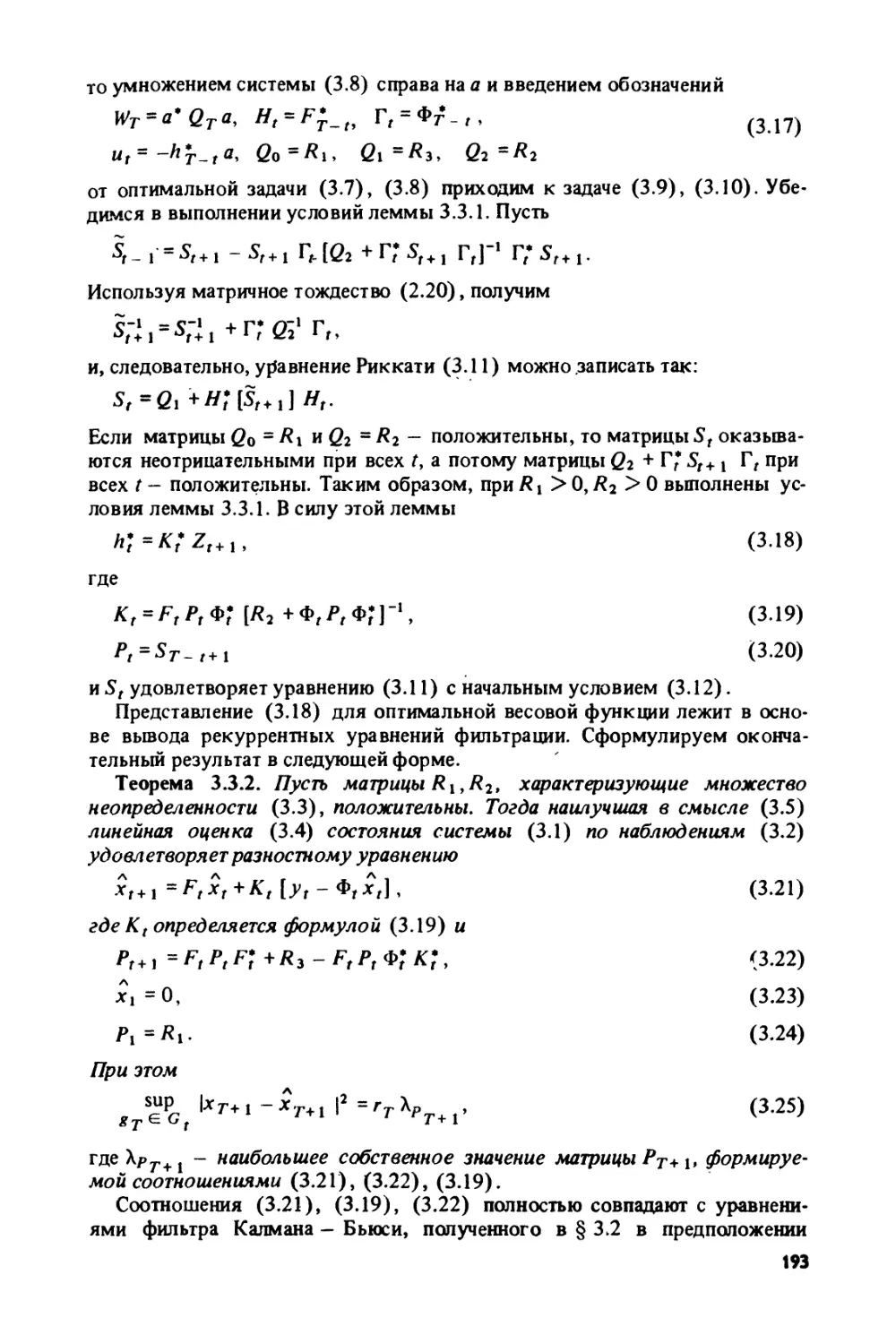

§ 3.3. Минимаксная фильтрация....................................... 190

3.3. Г. Постановка задачи (190). 3.3.2°. Двойственность задачи оценивания и

оптимального управления (191). 3.3.3°. Линейность оптимальной стратегии

управления (192). 3.3.4°. Рекуррентное соотношение для оптимальной оценки

(192). 3.3.5°. Оценивание параметров полезного сигнала на фоне нсцентриро-

ванной помехи (194).

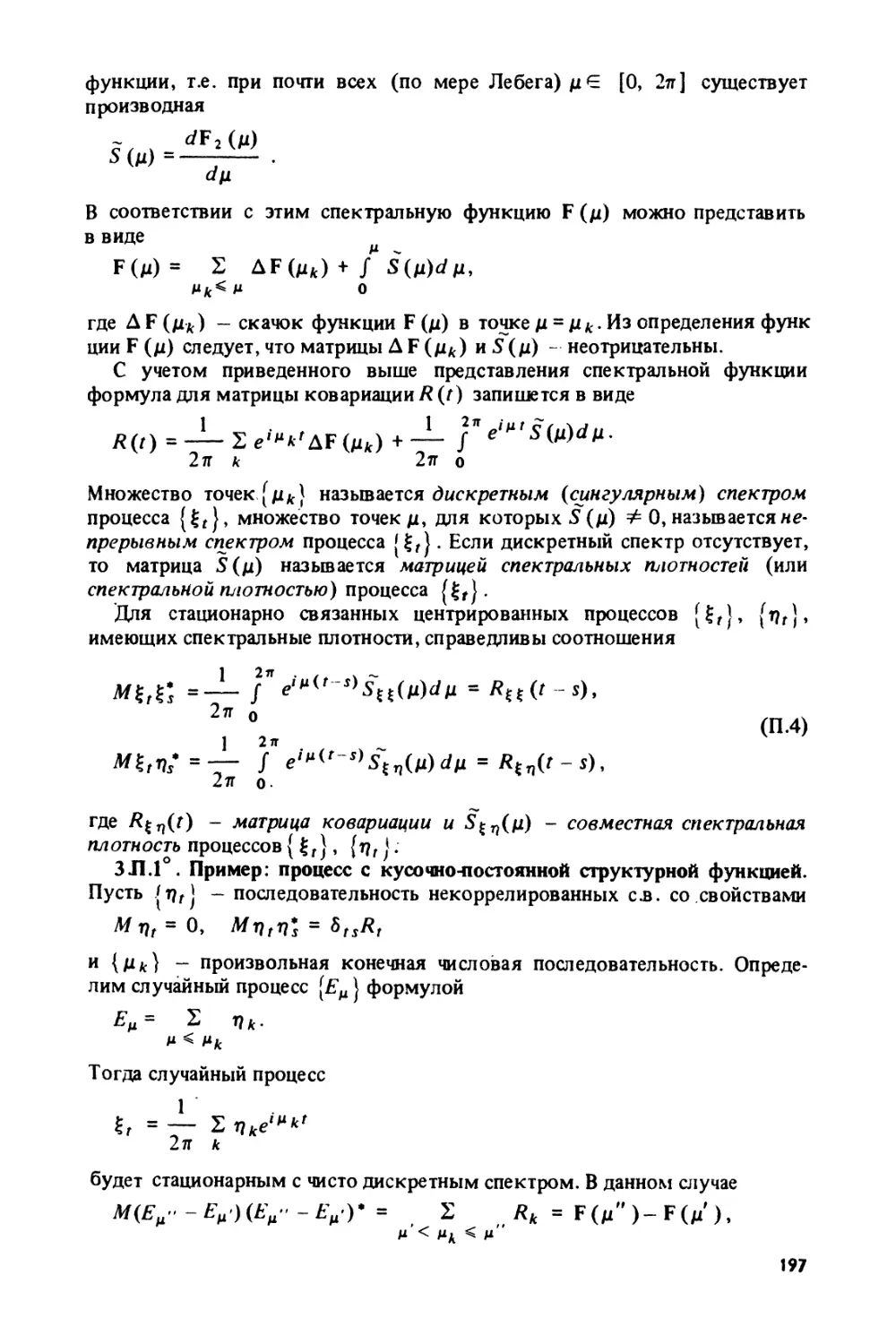

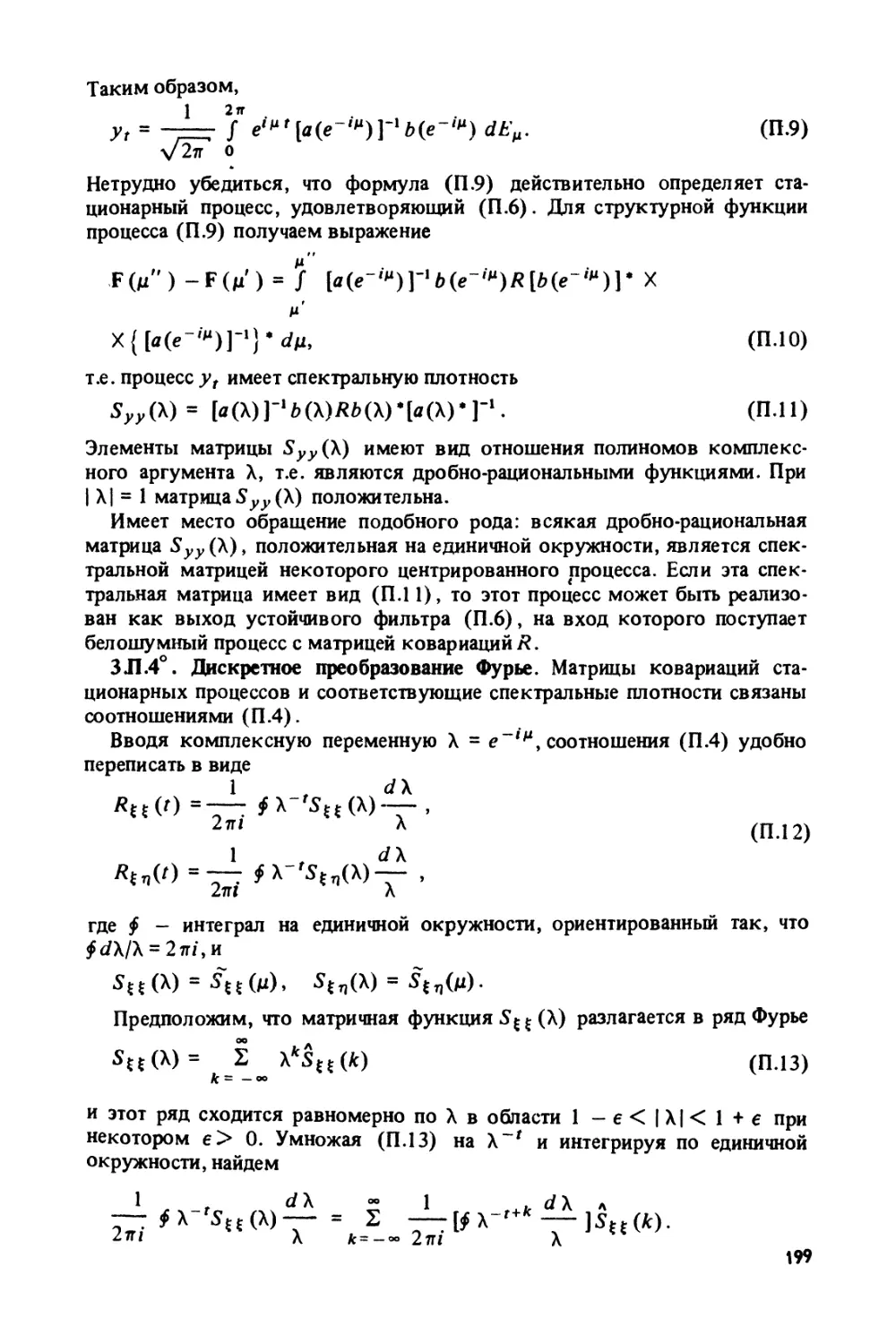

§ З.П. Приложение: некоторые сведения о стационарных процессах...... 196

З.П.1°. Пример: процесс с кусочно-постоянной структурной функцией (197).

З.П.2°. Пример: бслошумный процесс (198). З.П.З°. Пример: процесс с дроб-

но-рациональной спектральной плотностью (198). З.П.4°. Дискретное преобра-

зование Фурье (199).

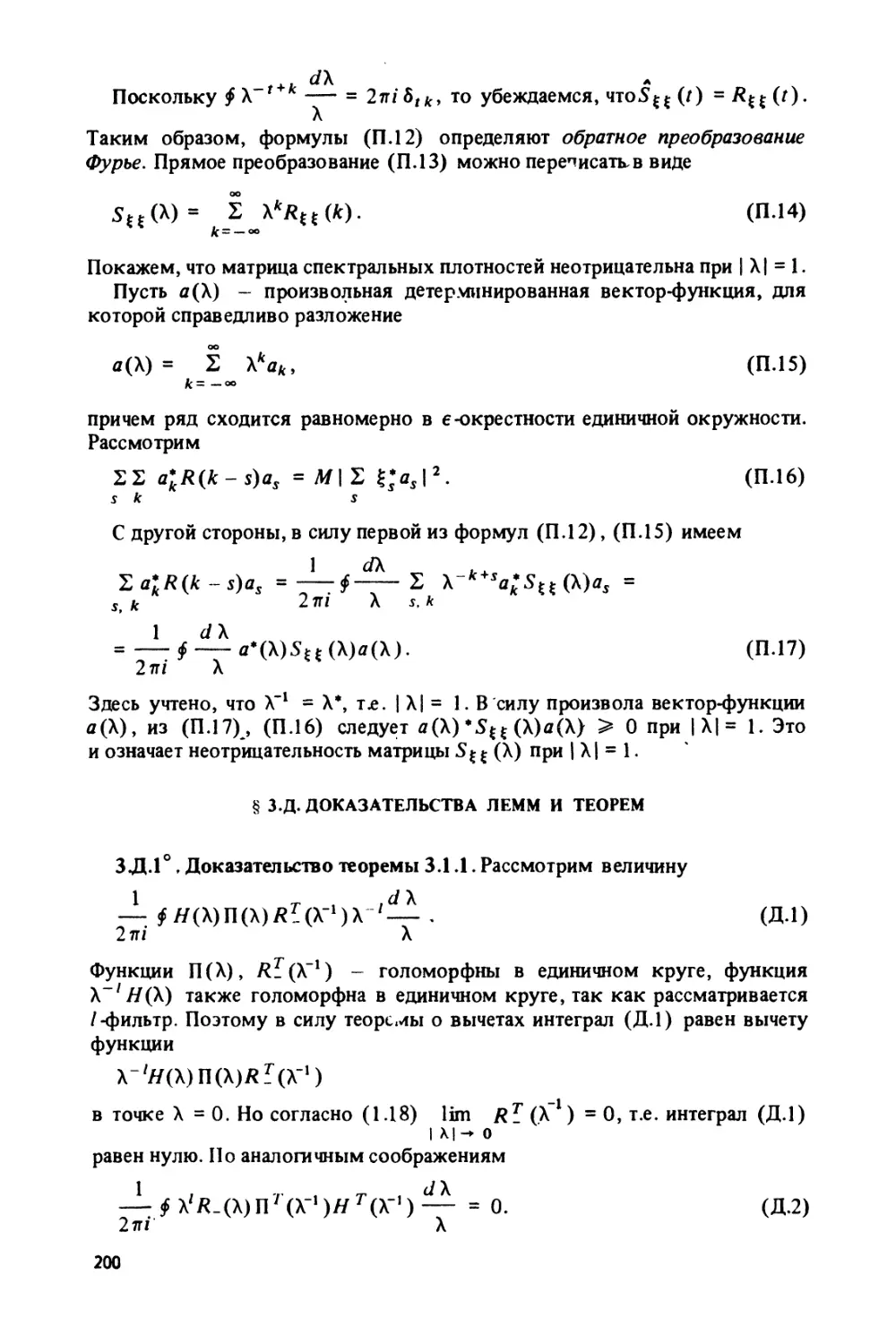

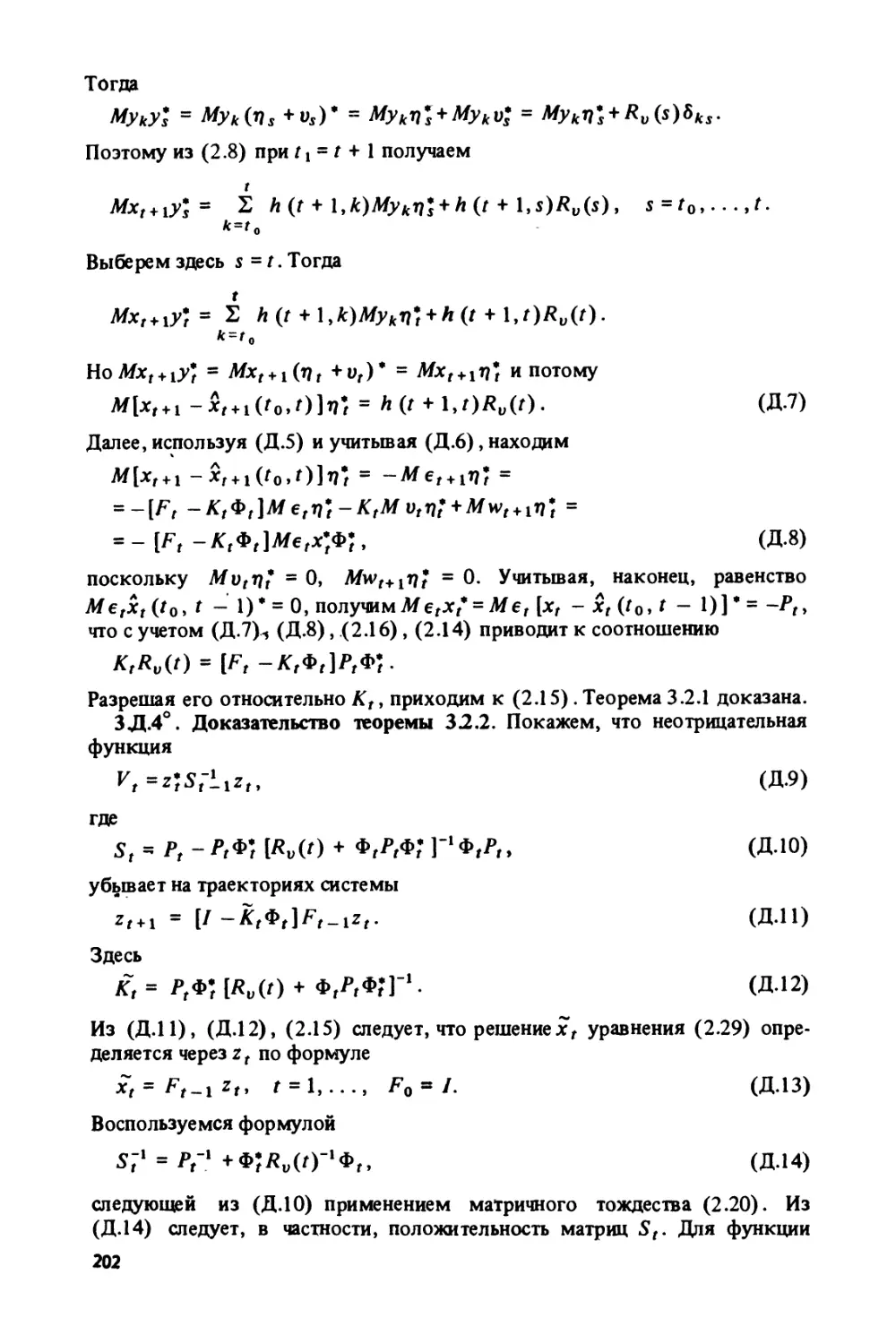

§ З.Д. Доказательства лемм и теорем................................. 200

З.Д. 1°. Доказательство теоремы 3.1.1 (200). З.Д.2°. Доказательство леммы

3 1.1 (Д01). З.Д.З°. Доказательство теоремы 3.2.1 (201). З.Д.4°. Доказа-

тельство теоремы 3.2.2 (202). З.Д.5°. Доказательство теоремы 3.2.3 (204).

З.Д.6°. Доказательство теоремы 3.2.4 (204). З.Д.7°.‘Доказательство теоремы*

3.3.1 (206). З.Д.8°. Доказательство леммы 3.3.1 (207). З.Д.9°. Доказательст-

во теоремы 3.3.2 (208). З.Д. 10°. Доказательство леммы 3.3.2 (209).

ГЛАВА 4

НЕКОТОРЫЕ ЗАДАЧИ АДАПТАЦИИ

§ 4.1. Адаптивные системы........................................... 210

4.1.1°. Модели взаимодействующих объекта и среды (210). 4.1.2°. Стратети

настройки параметров и цель функционирования объекта (211). 4 1.3°. Опре-

деление понятий адаптивной стратегии и адаптивной системы (213). 4.1.4°.

Классификация целей функционирования объекта (213). 4.1.5°. Замечания

(214).

§ 4.2. Примеры адаптивных систем.................................... 215

4.2.1°. Адаптивный классификатор (215). 4.2.2°. Адаптивные алгоритмы оце-

нивания (218). 4.2.3°. Адаптивное прогнозирование (219). 4.2.4°. Адаптив-

ные системы управления (221).

§ 4.3. Синтез адаптивных фильтров................................... 225

4.3.1°. Уточнение постановки задачи об адаптивной фильтрации (225). 4.3.2°.

Схемы оценивания неизвестных параметров (227). 4.3.3°. Идентификация

авторегрессионного процесса при белошумной помехе (230). 4.3.4°. Расши-

ренный МНК в задаче идентификации (232). 4.3.5°. Упрощенная процедура

5

расширенного МНК в задаче идентификации (233). 4.3.6°. Процедура стоха-

стической аппроксимации в задаче идентификации (234). 4.3.7°. Адаптивная

фильтрация (241).

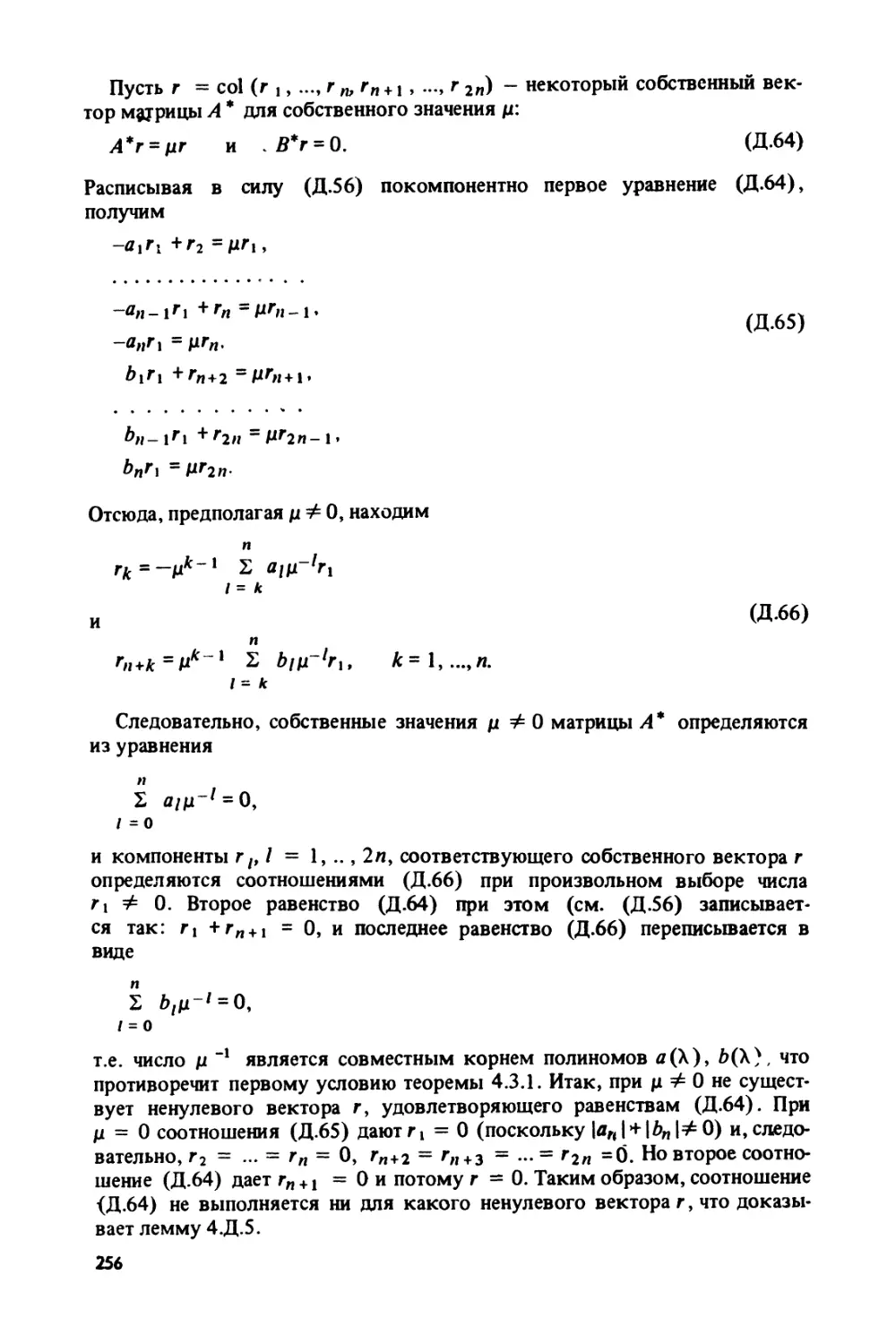

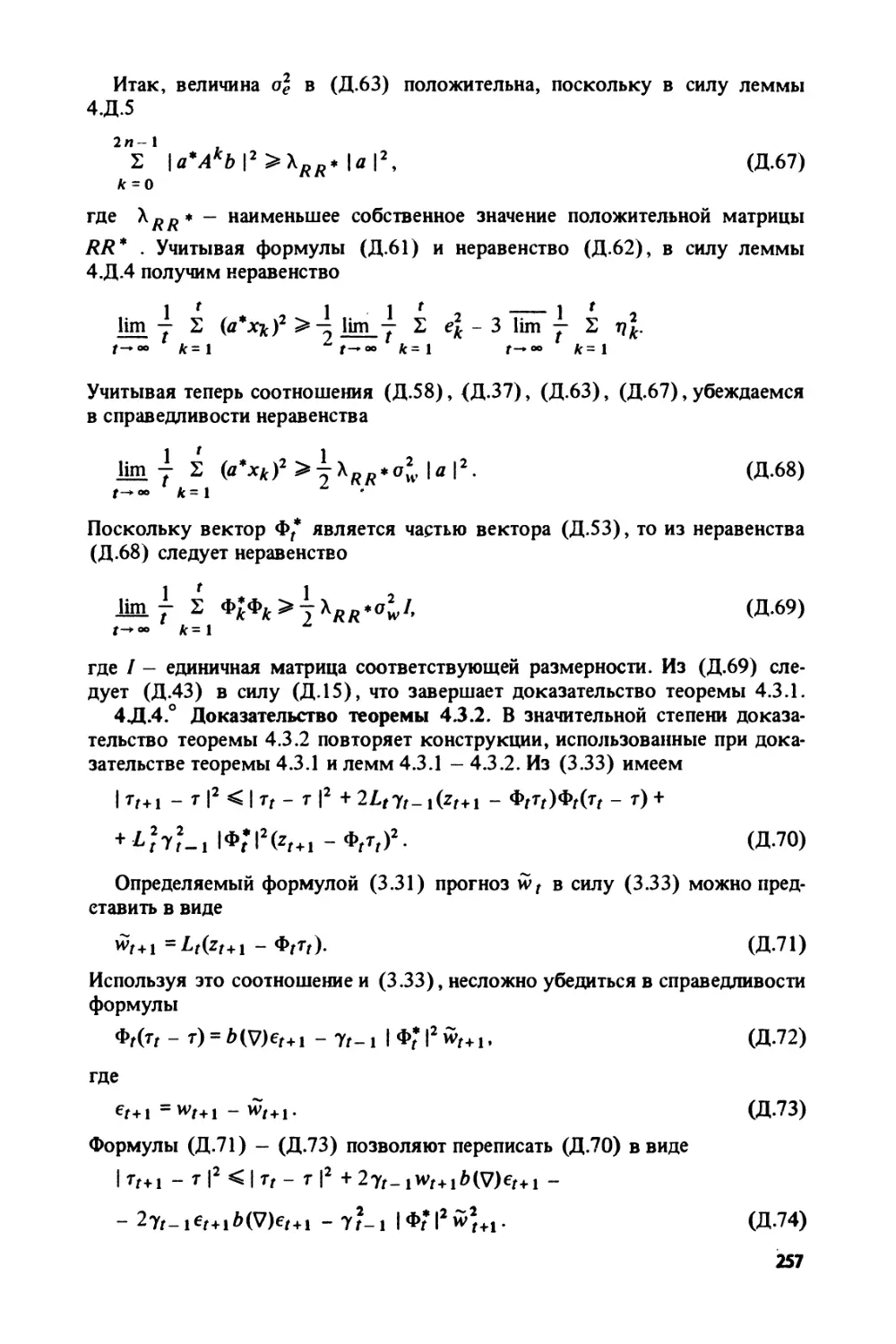

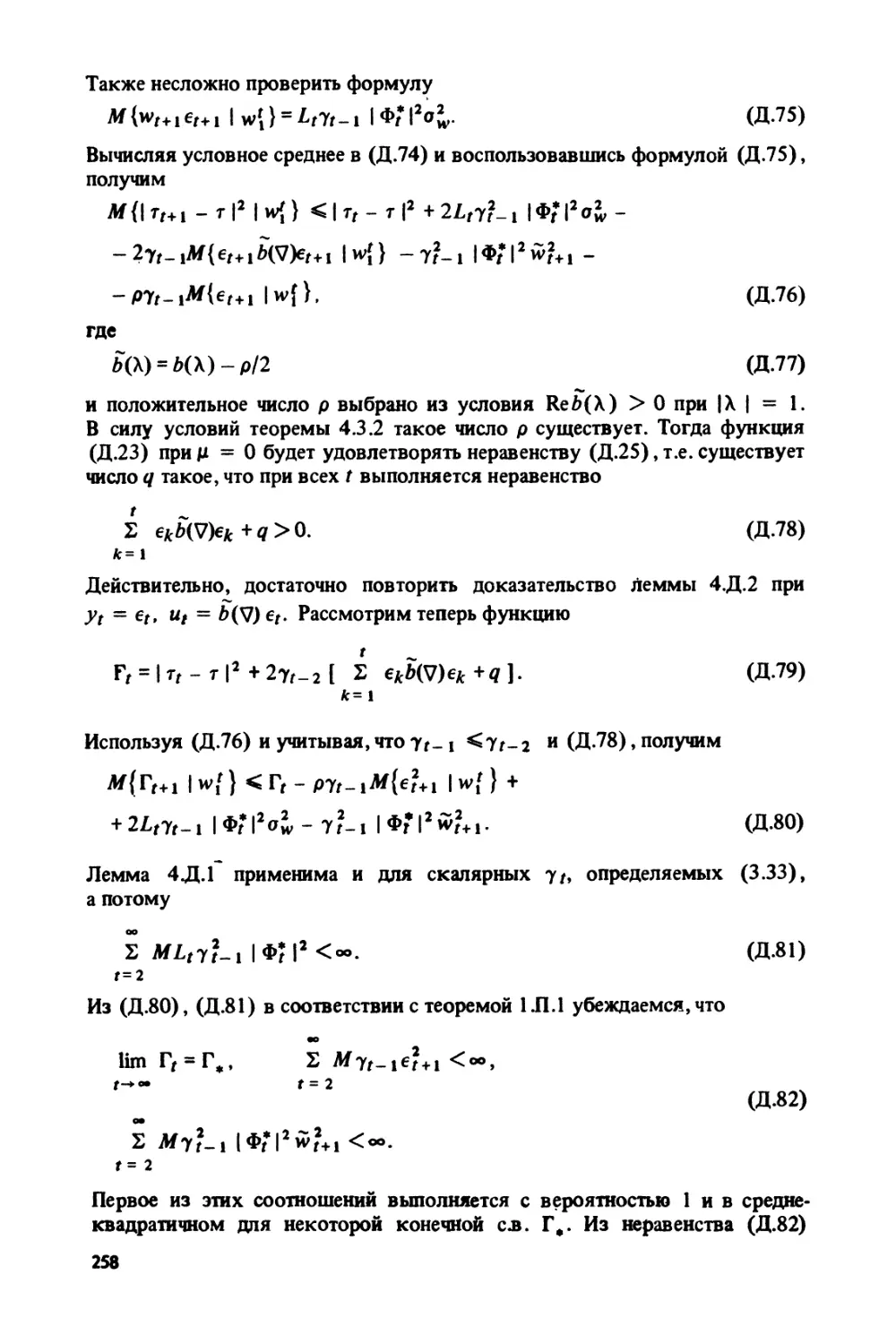

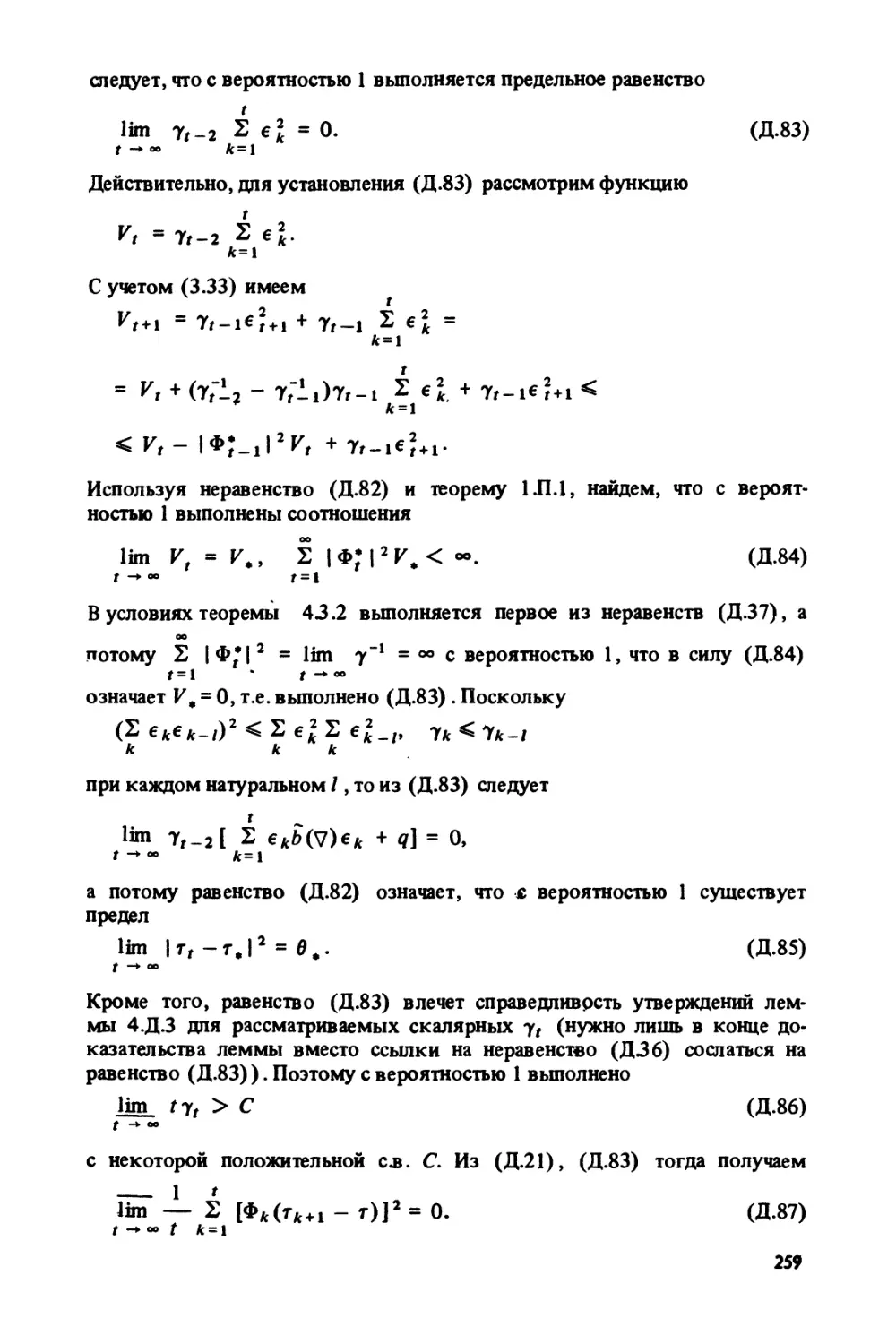

§ 4.Д. Доказательства лемм и теорем...................................... 244

4.Д.1°. Доказательство леммы 4.3.1 (244). 4.Д.2°. Доказательство леммы

4.3.2 (245). 4.Д.З°. Доказательство теоремы 4.3.1 (247). 4.Д.4°. Доказатель-

ство теоремы 4.3.2 (257). 4.Д.5°. Доказательство леммы 4.3.3 (261). 4.Д.6°.

Доказательство теоремы 4.3.3 (262).

Примечания и литературные указания....................................... 267

Литература............................................................... 277

Список основных сокращений и обозначений................................. 286

ПРЕДИСЛОВИЕ

Книга посвящена последовательному изложению ряда разделов теории

адаптивной фильтрации в условиях параметрической неопределенности о

помехо-сигнальной обстановке. Центральный вопрос теории - сочетание

оптимальных методов фильтрации (обработки) стохастических сигналов

с методами восстановления неизвестных параметров, определяющих

свойства полезного сигнала и помехи в канале наблюдения.

Фильтр, обеспечивающий успешную обработку принимаемого сигнала

в условиях априорной неопределенности о помехо-сигнальной обстановке,

здесь назван адаптивным. Задача синтеза адаптивных фильтров является

специальной в рамках теории адаптивных систем, получившей в последние

годы значительное развитие и, несомненно, составляющей один из централь-

ных разделов кибернетики. Именно в теории адаптивных систем получает

должное звучание мысль Н. Винера о важности понятий управления и связи

для описания самых различных процессов, протекающих в окружающем

нас мире.

В данной монографии сделана попытка описать современное состояние

лишь некоторых разделов теории адаптивных систем. Излагаемый матери-

ал группируется вокруг вопросов рекуррентного оценивания, при этом

обсуждаются как хорошо известные схемы оценивания (метод стохасти-

ческой аппроксимации, метод наименьших квадратов, метод максимума

правдоподобия), так и относительно новые схемы (минимаксное оцени-

вание, метод рекуррентных целевых неравенств, робастное оценивание).

Значительное внимание уделено методам синтеза оптимальных фильтров

(фильтр Винера-Колмогорова, фильтр Калмана-Быоси). Принятый в кни-

ге подход применим к многочисленным задачам оптимального обнаруже-

ния, обучения распознаванию образов, идентификации динамических объ-

ектов и многим другим, представляющим большой практический интерес.

В некоторых отношениях данную монографию можно рассматривать как

продолжение книги В.Н. Фомина, А.Л. Фрадкова, В.А. Якубовича ’’Адаптив-

ное управление динамическими объектами” (М.: Наука, 1981), в которой

вопросы адаптивной фильтрации и прогнозирования лишь намечены. Для

удобства читателя ниже сохранена и структура этой книги: доказательства

утверждений вынесены в специальные параграфы, ссылки на использован-

ные источники приводятся, как правило, лишь в примечаниях и литератур-

ных указаниях в конце книги, сохранена форма ссылок на формулы, опре-

деления и утверждения. Отметим, что понятия ’’шум”, ’’помеха”, ’’некон-

тролируемое возмущение” рассматриваются ниже как синонимы. Следует

подчеркнуть, что под помехой, сигналом и т.д. понимается соответствую-

щий процесс, а не его значения в те или иные моменты времени.

7

Книга предназначена в первую очередь для читателей с инженерным обра-

зованием, но для полного усвоения используемой в ней методики доказа-

тельств от читателя требуется достаточно высокая математическая подго-

товка. Для лучшего понимания основного содержания книги большинство

теоретических результатов иллюстрируется на модельных примерах. Она

может быть полезной широкому кругу специалистов в области теорети-

ческой и прикладной кибернетики, а также студентам старших курсов

и аспирантам, специализирующимся по математической кибернетике. В

основу книги положен двухсеместровый курс лекций, читаемый автором

на математико-механическом факультете Ленинградского университета.

В книге рассматриваются лишь системы, функционирующие в дискрет-

ном времени. Значительная часть полученных здесь результатов может

быть перенесена и на случай непрерывного времени, теория оценивания

и фильтрации в непрерывном времени даже более содержательна с мате-

матической точки зрения. Однако случай непрерывного времени требует

Излишней ’’математизации” теории, при этом ее ’’аппаратная” часть начинает

преобладать над практической содержательностью результатов теории, де-

лая их труднодоступными для читателя, на которого рассчитана книга. Кро-

ме того, теория адаптации, по убеждению автора, находится сейчас в той

фазе развития, когда ее оформление в самостоятельное научное направле-

ние не обязательно связано с обобщением уже разработанных методов

исследования дискретных систем.

Взгляды автора на обсуждаемый предмет формировались в рамках

научных семинаров кафедры теоретической кибернетики Ленинградско-

го университета. Автор с глубокой признательностью отмечает, что решаю-

щее влияние на формирование, его взглядов оказали беседы и дискуссии

с В.А. Якубовичем. Книга обязана своим появлением творческой атмос-

фере, сложившейся в группе адаптации упомянутой выше кафедры, и автор

благодарен членам этой группы, в первую очередь С.А. Агафонову, Г.С. Ак-

сенову, А.Е. Барабанову, Ю.Ф. Казаринову, Т.П. Красулиной, Н.А. Санкиной,

С.Г. Семенову, Б.М. Соколову и В.Ю. Тертычному. Можно без преувеличе-

ния сказать, что данная книга представляет коллективную точку зрения

группы на проблемы рекуррентного оценивания, и адаптации. Значительное

влияние на ’’усвоение” автором проблем адаптации оказали многочислен-

ные его беседы с С. В. Гусевым, О.Ю. Кульчицким, С.М. Хрящевым, Я.3. Цып-

киным. Рукопись книги любезно просмотрели В.Я. Катковник и В.Г. Сраго-

вич; их многочисленные замечания учтены в окончательной редакции.

Большую помощь в оформлении рукописи оказал автору Д.А. Пляко. Всем

перечисленным лицам автор выражает свою признательность.

ВВЕДЕНИЕ

Теория фильтрации и оценивания имеет богатую историю, но именно в

последние два-три десятилетия она заняла почетное место в рамках кибер-

нетики - науки, которая ’’занимается изучением систем любой природы,

способных воспринимать, хранить и перерабатывать информацию и исполь-

зовать ее для управления и регулирования” (А.Н. Колмогоров).

Все возрастающее значение методов теории фильтрации и оценивания

обусловлено, в первую очередь, запросами современного производства,

требующего быстрого развития и широкого внедрения сложных систем

управления и связи. Сложность этих систем обусловлена необходимостью

работать в широко изменяющихся диапазонах, при заранее непредсказу-

емых условиях, в режимах, затрудняющих или делающих невозможным

контроль со стороны человека. Теория фильтрации и оценивания, наряду

с другими математическими теориями, обеспечивает базу для создания та-

кого рода систем.

Теория оценивания как математическая наука была основана в 1806 г.,

когда появилась работа Лежандра о наименьших квадратах. Эту честь раз-

деляет и Гаусс, опубликовавший свою версию метода наименьших квадра-

тов (МНК) в 1809 г. В этот период стимулом развития МНК служили за-

просы небесной механики, и метод быстро становится стандартным для

определения орбит небесных тел. Неудивительно, что среди авторов работ

по небесной механике мы находим имена Бесселя, Лапласа, Пуассона,

Лагранжа, известных своим вкладом и в основания статистики.

Постепенно методика оценивания была поглощена статистикой, но не

сразу в достаточно строгой математической форме. Лишь в течение послед-

них десятилетий теория вероятностей и важнейшие разделы статистики

получили соответствующее математическое оформление, прежде всего,

благодаря использованию концепций теории меры.

Современное состояние теории оценивания заложено Р.А. Фишером

в 20-х годах нашего столетия. Фишер показал, что метод максимума

правдоподобия обычно удобнее МНК и доставляемые им оценки не мо-

гут быть в существенном улучшены. Фишером также введены ставшие

общепринятыми понятия несмещенности, достаточности, состоятельности,

эффективности и асимптотической эффективности оценок. Тщательно

рассматривая основания теории оценивания, Фишер избавил ее от жест-

ких ограничений, существовавших с момента появления работ Гаусса.

Обобщения его теории привели, в частности, к развитию современных

методов непараметрического и робастного оценивания, в которых точ-

ная природа распределения вероятностей оцениваемых случайных величин

не предполагается известной.

9

Одновременно с формализацией и развитием теории вероятностей и ста-

тистики проводились исследования в, казалось бы, далеких от них облас-

тях, но именно этим исследованиям предстояло оказать на теорию оценива-

ния еще большее воздействие. До 1940 г. оценивание касалось, прежде

всего, классических проблем определения наилучших оценок распределе-

ний параметров на основе выборки из генеральной совокупности. Между

тем, специалисты по линиям связи имели дело с задачей синтеза устройств,

позволяющих эффективно обнаруживать присутствие или отсутствие сиг-

нала, наблюдаемого на фоне помехи, и именно их исследования составили

конкуренцию статистическим исследованиям Фишера. Быстрое развитие

теории связи привело к необходимости учета воздействия помех на рас-

пространение и прием сигналов. Первые попытки уменьшить нежелатель-

ное воздействие помех были связаны с введением методов расчета фильт-

ров, позволяющих оценить спектр мощности полезного сигнала. Эти по-

пытки делались в нужном направлении, но были ограниченными из-за недос-

таточности развития теории фильтрации. Математические основы этой тео-

рии только закладывались: в начале 30-х годов А.Я. Хинчин и Н. Винер соз-

дали теорию гармонического анализа случайных функций, центральное мес-

то в которой занимает теорема о спектральном представлении Стационар-

ных процессов.

В конце 40-х годов закладываются основы статистической теории связи,

или теории информации. В 1947 г. в докторской диссертации В.А. Котель-

никова ’’Теория потенциальной помехоустойчивости” впервые формулиру-

ется задача оптимального статистического синтеза приемных устройств

и дается решение задачи обнаружения и различения детерминированных

сигналов на фоне коррелированной помехи. Здесь с новых позиций анали-

зируются фундаментальные понятия. Спустя немногим более года появ-

ляется известная работа К. Шеннона, содержащая знаменитые теоремы о

кодировании передаваемых сигналов с целью устранения избыточной ин-

формации и о пропускной способности каналов со случайными помехами.

Фундаментальные результаты, полученные В.А. Котельниковым и К. Шен-

ноном, представляют основополагающий вклад в статистическую теорию

связи.

В то же время Н. Винер публикует книгу ’’Кибернетика, или управление

и связь в животном и машине”, возвестившую о становлении новой науки,

в которой информационно-управленческая связь в явлениях материального

мира выступает как фундаментальное его свойство.

За последующие три десятилетия методы статистической теории связи

значительно усовершенствовались, вопросы приема сигналов начинают

рассматриваться с позиций статистических решений. Теория оптимальной

фильтрации оплодотворяется байесовской идеологией, центральное место

в которой занимают идеи последовательного статистического анализа Валь-

да. Структура оптимального приемника-обнаружителя определяется теперь

из анализа отношения правдоподобия и при определенных условиях

приводит к согласованному фильтру, максимизирующему отношение

”сигнал/шум” на входе решающего устройства.

Наряду с проблемой обнаружения на первый план в статистической тео-

рии связи выдвигаются проблемы различения сигналов и восстановления

сообщений. Эти проблемы оказываются тесно связанными с оценкой па-

10

раметров, от которых могут зависеть принимаемые сигналы. Так, напри-

мер, проектировщики радиолокатора уже не удовлетворяются решением

только проблемы детектирования сигнала, но также желают знать амплиту-

ду и фазу принятых радиолокатором сигналов. Хотя первоначально преоб-

разование сигналов и оценивание их параметров подвергалось изучению

со специальными целями, вскоре было установлено, что после соответствую-

щей интерпретации эти проблемы естественно укладываются в рамки

статистики. Немаловажное значение имела и популяризация статистичес-

ких методов среди инженеров-проектировщиков систем связи.

Другой подход к проблеме передачи информации в условиях помех

был предложен А.Н. Колмогоровым в работе, опубликованной в 1939 г.

в ’’Докладах французской академии наук”. Через два года эти результаты

были опубликованы в СССР. В 1942 г. в закрытом отчете, написанном по

заданию Национального Совета оборонных исследований США, подобные ре-

зультаты независимо получает Н. Винер. Эти работы и заложили основы

теории оптимальной фильтрации стационарных процессов. Винер, в част-

ности, показал, что теория оценивания может быть применена для синте-

за электрического фильтра, который обеспечит наилучшее выделение сиг-

нала при наличии стационарной помехи. При этом он делал упор не столько

на рассмотрение частотных спектров сигналов, сколько на их обработку

как стохастических процессов.

Развитие статистической теории связи было результатом быстрого

восприятия винеровской идеи. Более того, как это обычно бывает с каж-

дым значительным продвижением в науке, были разработаны различные

модификации оригинального метода (например, широкое признание среди

инженеров-проектировщиков систем связи получила интерпретация Боде -

Шеннона процедуры синтеза оптимального фильтра).

На первый взгляд теория Винера-Колмогорова кажется в существенном

основанной на методе наименьших квадратов, и это действительно так. Од-

нако оценивание параметров в этой теории происходит на основе обработки

входных данных в виде стохастического процесса, что приводит к важным

концепциям физической реализуемости и оптимальности синтезируемого

линейного фильтра. Теория не только доказывает существование оптималь-

ного фильтра, но и в принципе позволяет его синтезировать. Центральным

местом теории оптимальной фильтрации Винера ~ Колмогорова является

уравнение Винера - Хопфа, решение которого непосредственно связано с

синтезом оптимального фильтра. Аналитические трудности решения этого

уравнения (в частности, проблема факторизации) явились главным пре-

пятствием на пути широкого внедрения методов фильтрации в практику.

Кроме того, значительным ограничением для многих приложений было

важное предположение о стационарности обрабатываемого сигнала.

В конце 50-х годов при исследовании опгимальных фильтров, синтези-

руемых при обработке результатов наблюдения на конечном интервале

времени, были предложены подходы, не использующие интегральное урав-

нение Винера - Хопфа. Первоначальный импульс для создания активности

в новом направлении был дан Р. Калманом и Р. Бьюси. Независимо друг

от друга они поняли, что вместо исследования уравнения Винера Хопфа

с его трудностями факторизации часто бывает желательно (и возможно)

превратить интегральное уравнение в нелинейное дифференциальное, реше-

11

ние которого даст ковариацию ошибки оптимального фильтра. В свою оче-

редь, эта ковариация содержит всю необходимую информацию для проек-

тирования оптимального фильтра. Этот подход, по существу представляю-

щий собой рекуррентный варрант МНК, в частных случаях исследовался

ранее и другими авторами, но именно с работ Р. Калмана и Р. Бьюси в на-

чале 60-х годов началось широкое развитие методов теории рекуррентно-

го (последовательного) оценивания, в рамках которой задача оптималь-

ной фильтрации получила существенное продвижение. Возможность синте-

за оптимального фильтра рекуррентным способом представляла и большой

практический интерес в связи с удобством реализации фильтра на базе

современной вычислительной техники. Рекуррентные процедуры оценивания

(фильтр Калмана-Бьюси) оказались применимыми и в случае нестационар-

ных процессов, что в рамках теории Винера-Колмогорова представляло

трудную проблему.

Работы Р. Калмана по рекуррентному оцениванию появились в связи

с необходимостью оптимального оценивания вектора состояния линей-

ных нестационарных систем. Оценивание производилось по наблюдению

за зашумленной компонентой вектора состояния. В теоретическом плане

здесь существенным моментом является линейная зависимость наблюдае-

мого процесса от оцениваемого параметра (линейная фильтрация). Вместе

с тем, многие практические задачи приводят к нелинейной зависимости дан-

ных наблюдения от оцениваемого параметра. Этот раздел теории оценива-

ния - нелинейная фильтрация - развит значительно меньше, чем линейная

фильтрация. Центральные идеи здесь были выдвинуты в 1960 г. Р.Л. Стра-

тоновичем; предложенная им рекуррентная процедура оценивания в линей-

ном случае преобразуется в фильтр Калмана-Бьюси.

Развитие и доступность вычислительной техники оказали невиданное

воздействие на теорию фильтрации и оценивания. Если до эры ЭВМ анали-

тики затрачивали огромные усилия на формулировку решений в замкнутой

форме простых вычислительных алгоритмов, то современная тенденция

состоит в программировании всей проблемы с тем, чтобы возложить на

ЭВМ решение задачи. Проблемы нелинейного оценивания, которые до сих

пор старательно обходились из-за трудности аналитических исследований,

сейчас рассматриваются как рутинные при использовании ЭВМ.

Совершенствование вычислительных устройств оказало воздействие

и на классические разделы математической статистики, стимулируя разра-

ботку и давая приоритет рекуррентным схемам оценивания. Так, получили

широкое признание процедуры стохастической аппроксимации Роббинса -

Монро (1951) и Кифера-Вольфовица (1952). Не обладая оптимальными

свойствами рекуррентных модификаций МНК, они позволяют получать

состоятельные оценки неизвестных параметров, демонстрируя преимущест-

во перед, оптимальными схемами в простоте вычислительных процедур

и в универсальности применения.

Теория фильтрации и оценивания в последние годы получила новое

звучание в связи с необходимостью синтезировать адаптивные системы,

способные успешно функционировать в условиях априорной неопределен-

ности о свойствах внешней среды. Так, синтез оптимального фильтра

предполагает известными некоторые априорные свойства сигналов и

помех.

12

В большинстве практических задач эта информация недоступна проекти-

ровщику оптимальных фильтров, но ее можно в той или иной степени вос-

полнить из анализа принимаемых сигналов. Если такая возможность име-

ется, то можно синтезировать фильтры, в которых совмещены процессы

фильтрации и восполнения недостающей информации. При достаточно эф-

фективном восполнении недостающих сведений фильтр приобретает опти-

мальные свойства либо близкие к ним; такие фильтры называют адаптив-

ными, поскольку в процессе функционирования они проявляют свойство

’’приспосабливаться” к заранее неизвестным помехосигнальным условиям.

Сама возможность синтеза адаптивных фильтров также предполагает

выполнение некоторых априорных условий о свойствах помехо-сигнальной

обстановки, но эти условия обычно имеют более общий характер, чем те,

которые использовались при оптимальной фильтрации. Так, например,

фильтр Винера-Колмогорова предполагает не только стационарность по-

лезного сигнала и помехи, но и знание их спектральных характеристик.

Примененный в другой помехо-сигнальной обстановке, такой фильтр

может не выполнять возложенных на него функций. В этих условиях

фильтр, не использующий знания спектральных характеристик (а, воз-

можно, восстанавливающий их в процессе анализа принимаемого сигнала)

и в то же время приспосабливающийся к произвольной стационарной

помехо-сигнальной обстановке, будет проявлять свойства адаптивности

к неизвестным характеристикам помехо-сигнальной обстановки. Более

сложные фильтры, возможно, смогут приспосабливаться и к другим,

не обязательно стационарным помехо-сигнальным условиям, и они будут

обладать другим, более высоким уровнем адаптации и т.д. Из сказанного

ясно, что само понятие адаптивности зависит от того, какова цель функцио-

нирования данного устройства (фильтра) и при каких помехо-сигнальных

условиях она обеспечивается. Эти условия определяют класс адаптивности

данного устройства, и устройство, адаптивное в одном классе, может не

быть адаптивным для другого множества условий либо по отношению к

другой цели функционирования.

Использование адаптивных фильтров делает процесс фильтрации более

гибким, но реализация адаптивных фильтров становится более сложной

и требует обычно большего объема вычислений и памяти вычислитель-

ных устройств. Успешное проектирование адаптивных фильтров возможно,

видимо, лишь на пути развития рекуррентного синтеза, когда ’’настройка”

параметров фильтра осуществляется по мере поступления новых данных

наблюдения. Такой подход позволяет установить разумный компромисс

между необходимым быстродействием вычислительных устройств и требуе-

мым объемом их памяти с тем, чтобы обеспечить своевременную обработ-

ку больших объемов данных наблюдения.

Сказанное в равной степени относится и к другим адаптивным устрой-

ствам, в частности, к обучающимся машинам и самонастраивающимся

регуляторам. При синтезе таких устройств теория фильтрации и оценивания

играет важную роль, доставляя рекуррентные алгоритмы адаптации.

Цель этой книги - дать представление о современном состоянии некото-

рых разделов теории фильтрации и оценивания, а также подчеркнуть значи-

мость этих методов для решения разнообразных задач адаптации.

ГЛАВА 1

ЗАДАЧИ И МЕТОДЫ ТЕОРИИ ОЦЕНИВАНИЯ

Под оцениванием понимается способ уточнения значений параметров

сигнала, наблюдаемого на фоне помехи. Для нужд теории оценивания раз-

виты специальные методы математической статистики, б частности, регрес-

сионный анализ, основанный на методе наименьших квадратов. Новый

взгляд на регрессионный анализ связан с развитием электронно-вычислитель-

ной техники, стимулировавшей широкое распространение рекуррентных

процедур оценивания. В данной главе дается краткое описание некоторых

из методов регрессионного анализа и других методов статистического оце-

нивания, а также перечисляются некоторые задачи обучения, самообучения,

обнаружения, решение которых сводится к оцениванию соответствующих

параметров.

§ 1.1. ПРИМЕРЫ ЗАДАЧ ОЦЕНИВАНИЯ

Прежде чем переходить к описанию методов оценивания, полезно иметь

перед собой коллекцию задач, для которых эти методы предназначены.

Перечисляемые ниже задачи являются модельными, но, как представляется,

демонстрируют достаточно широкую область применения методов оцени-

вания.

1.1.1 °. Оценивание величины постоянного сигнала, наблюдаемого на

фоне помехи. Предположим, что наблюдаемый (регистрируемый измери-

тельным прибором) сигнал имеет вид

yt-T + vt, (1.1)

где т - постоянная величина (полезный сигнал), {vr} - помеха наблюде-

ния, изменяющаяся во времени t = 1,2,.... Требуется по наблюденным

значениям у * = (у^,... ,yt) оценить величину т.

В такой общей постановке решение даже столь простой задачи едва Ли

возможно. Обычно о свойствах помехи { vt} делаются те или иные предпо-

ложения, позволяющие воспользоваться статистическими методами. Напри-

мер, характерно предположение о центрированности и некоррелированнос-

ти помехи {и,}. При таком предположении могут применяться различные

схемы усреднения типа

1 ' 1 t

- X X (1.2)

t s =1 t 1

позволяющие сгроить оценки rt величины т в виде

1 f

Z ys. (1.3)

l s ~ 1

14

В силу закона больших чисел величина — S vs сходится в различных

t $ = 1

вероятностных смыслах к нулю, что в соответствии с (1.2) приводит к

сходимости оценок (1.3) кт. Возможны другие способы получения оценок

неизвестной величины т; важен вопрос о наилучших оценках, понимаемых

в том или ином смысле. Интересен также вопрос о скорости сходимости

оценок (в частности, оценок (1.3)) к неизвестной величине т, но ответ на

него получен лишь в простейших случаях.

1.1.2 °. Задача оптимального оценивания параметров сигнала. Наблюдае-

мый сигнал {yt} может иметь более сложную структуру:

yt = $г(т,к) + и,. (1.4)

Здесь {%}- изменяющийся во времени полезный сигнал, зависящий

известным образом от набора т информационных (существенных) парамет-

ров и набора к паразитных параметров; {щ}~ помеха наблюдения. Тре-

буется оценить информационные параметры т.

При решении этой задачи также накладываются ограничения на входя-

щие в (1.4) величины. В ряде случаев параметры т, к предполагаются

случайными с известными статистическими свойствами. В другом варианте

набор параметров может быть неслучайным (например, в задаче о выделе-

нии скрытых периодичностей полезный сигнал представляет собой тригоно-

метрический полином с неизвестными частотами).

Обычно интерес представляет получение наилучших (оптимальных)

оценок, что предполагает задание критерия качества оценок. Критерий

качества состоит в требовании экстремизации (минимизации либо макси-

мизации) некоторого функционала, называемого функционалом качества.

Таким функционалом может быть, например,

И/Г(/) = М{ S ljr-sr(r»|2lr},

t = i

где Т — время наблюдения сигнала и М означает операцию усреднения по

ансамблю реализаций сигналов {>’,} , {$,} , отвечающих фиксированному

значению параметра т. В другом варианте задачи оценивания, когда интер-

вал наблюдения бесконечен, функционал качества может иметь вид

, — 1 т

W(r)= sup lini — Z |^f - Sf (т ,k) I,

кек т-> °° T

где К — множество возможных значений паразитного сигнала к. Вычисле-

ние первого из приведенных функционалов предполагает знание статистики

сигналов {} , {sr} , во втором случае значение функционала полностью

определяется реализациями этих процессов. Возможны и другие разнообраз-

ные функционалы качества, минимизация которых определяет оптималь-

ную (в смысле соответствующего функционала) оценку.

1.1.3°. Задача обнаружения сигнала. В задачах обнаружения сигнала

оцениваемая величина (обозначим ее через в ) принимает конечное число

значений и часто представляет собой характеристику типа ”да - нет”.

15

Наблюдается сигнал

yt = 0st + vt, r=l,2,...,T, (1.5)

где величина в характеризует наличие сигнала {s,} (0 = 1) либо его отсутст-

вие (0 = 0). Возникает задача оценивания величины 0 , что можно интерпре-

тировать как задачу обнаружения сигнала, наблюдаемого на фоне помехи.

При определенных предположениях о статистических свойствах с.в st, vt за-

дача допускает решение, оптимальное в различных смыслах. При этом вели-

чина st может быть известной (и тогда все сводится к задаче оценивания

параметра 0 ), либо неизвестной (что осложняет задачу).

1.1.4°. Задача о разладке. Близкой по смыслу к предыдущей задаче

является следующая задача: наблюдаемый процесс имеет вид

yt = st(Tt) + vt, (1.6)

где Tt - величина, определяющая статистические свойства полезного сигна-

ла. Величина эта, по предположению, изменяется во времени, оставаясь

постоянной на интервалах значительной продолжительности. Требуется

оценить моменты времени, когда происходит ’’переключение” величины т,.

В более частном варианте Tt может, например, принимать лишь два значения

и иметь смысл среднего значения полезного сигнала. В этом случае требует-

ся определить моменты времени, называемые моментами разладки, когда

изменяется среднее значение полезного сигнала. Задача о разладке полезна

при определении моментов начала и окончания действия полезных сигналов,

при выделении фонем в речеподобных сигналах и т.д.

1.1.5°. Аппроксимация функции с помощью линейных комбинаций

известных функций. Задача об аппроксимации функции по ее значениям

(в некоторых точках) имеет широкую область применения. Формулировка

задачи состоит в следующем. Предположим, что значения функции Дх), оп-

ределенной на множестве X, известны в точках xf, х, Е X. Пусть av (х), . . .

.. . ,ai (х) - заданные функции, определенные на том же множестве. Требу-

ется аппроксимировать f (х) с помощью линейной комбинации функций

{а/ (х)}:

S т(Ч(х). (1.7)

1= 1

Коэффициенты этой комбинации выбираются в зависимости от того,

как понимается аппроксимация, что связано с заданием критерия качества

аппроксимации. Предположим, что критерий качества задан и определяе-

мый этим критерием набор коэффициентов r[l\i =1,2,...,/, найден. Тогда

f (х) в точках х,, t = 1,2,..., Г, можно представить в виде

/(*,) = S 7<'>а(х,)+и„ (1.8)

/ = 1

где {vt} трактуется как ошибка измерения полезного сигнала

/

st- Етр’)а(хг). (1.9)

/ = 1

Требуется по наблюдениям^, = st + vt оценить вектор т» = col (/J \ .. ., rV>).

16

При функционале качества

WT(T)= I l(r,a(xt))-f(xt)?, (J.10)

t = 1

/

где (г, а) = Е а,, решение поставленной задачи свелось к применению

/ = ।

метода наименьших квадратов. При определенных предположениях реше-

ние может быть найдено с помощью рекуррентных процедур, увеличиваю-

щих точность аппроксимации по мере поступления новых точек xt и сооб-

щении о ’’зашумленных” значениях f (xt) в этих точках.

1.1.6 °. Модель обучаемой системы. Конкретизация задачи п. 1.1.5 ° при-

водит к различным вариантам задачи обучения. Пусть имеется некоторая

система, организованная следующим образом: при предъявлении ей входно-

го сигнала (стимула) хона ’’вырабатывает” значения функций ах (х),...

. . ,Я/(х), определяющих ее структуру, и может вычислять величину (1.7)

с некоторыми весовыми коэффициентами Тем самым определяются

множества (образы)

*1 (т)= {x:/z (т, х) > 0} , X2(7)={x:/z(7,x)<0), (1.11)

и рассматриваемая система в состоянии теперь ’’классифицировать” любой

входной сигнал х, относя его либо к множеству (т), либо к множеству

%2 (т). Эта классификация может изменяться, если варьировать коэф-

фициенты Система, дополненная способом изменения весовых коэффи-

циентов, может ’’подгонять” свою классификацию к некоторой требуемой

и тем самым демонстрировать свойство обучаемости, или адаптации. Такая

подгонка требует определенной информации о требуемой классификации,

и эта информация поступает с обучающей последовательностью xt,.. .хг,

состоящей из классифицированных требуемым образом входных сигналов.

Уточнение характера этой информации приводит к различным постановкам

задачи обучения. Сам процесс подбора весовых коэффициентов с помощью

обучающей последовательности носит название процесса обучения; по

окончании процесса обучения весовые коэффициенты фиксируются и

множества (1.11) принимаются, в качестве требуемого разбиения. Они,

разумеется, могут не совпадать с требуемым разбиением, их отличие, выра-

женное каким-либо способом, определяет качество работы ’’обученной”

системы.

Естественным образом задача обучения обобщается на случай числа клас-

сов, большего двух.

Описанная выше схема обучаемой системы может быть реализована с

помощью так называемых персептронов — сложных сетей из пороговых

элементов (формальных нейронов), предназначенных для моделирования

процесса обучения в живых организмах. Роль функций Я/ (х) здесь играют

реакции выходных нейронов сети на входной стимул х (по аналогии с

работой зрительной системы входные стимулы иногда называют изображе-

ниями) . Величины играют роль коэффициентов усиления сигналов

выходных нейронов сети, эти усиленные сигналы поступают в эффектор-

ный нейрон, где они суммируются и сравниваются с порогом (в данном

случае - с нулем). В результате такого сравнения принимается решение о

17

принадлежности входного стимула к одному из двух классов. Поступаю-

щая в процессе обучения (в процессе настройки коэффициентов усиления)

дополнительная информация о требуемой классификации интерпретирует-

ся как указание ’’учителя” о классификации обучающей последовательнос-

ти, поэтому описанную задачу иногда называют "обучением с учителем ”.

Возможна постановка задачи обучения,где указания ’’учителя” отсутствуют,

эта задача часто называется задачей самообучения.

Приведем два возможных варианта задачи ’’обучения с учителем”, разли-

чающихся конкретизацией информации о требуемой классификации.

а) Детерминистская постановка задачи обучения. Предположим, что

требуемое разбиение множества X определяется множествами (1.11) при

т = т*, но значение т* нам неизвестно. Введем функцию

f(x) = sign ft (т., х) (112)

и будем предполагать, что ее значения известны на обучающей последова-

тельности хь .. ., хт. Таким образом, ’’указания учителя” в данном случае

сводятся к предъявлению обучаемой системе наряду со стимулами (изоб-

ражениями) xit.. ., хт последовательности/(хД... ,/(хД а весовые

коэффициенты требуется определить из условия совпадения знаков

функций f(x)nfi (т, х) на обучающей последовательности, т.е. из неравенств

i

f(xt) S т('>а,(х,)>0, 7=1,2,Т. (1.13)

/= 1

Неравенства (1.13) определяют своеобразную аппроксимацию функции

f(x) с помощью линейной комбинации функций а{ (х), именно, аппроксима-

цию ”по знаку”. При сделанном предположении (1.12) система неравенств

(1.13) разрешима, и всякий алгоритм определения ее решения может

интерпретироваться как процесс обучения.

Описанная задача называется детерминистской, так как она предполагает

возможность безошибочной классификации (классы изображений Xt (тД

Х2 (т*)не пересекаются). Задача допускает ясную геометрическую интер-

претацию. Действительно, обозначим через Rz евклидово пространство

размерности I. Тогда функции {а( (х)}, z = 1,2,..., определяют отображе-

ние z : X-+R1, сопоставляя каждому х .Е X точку

z = z (х) = col (ai (х),... ,ai (х)) (1.14)

из R7. При таком отображении множества Хх (т),Х2 (т) перейдут в мно-

жества Zi (г) - z (Xi (г)), Z2 (т) = z (Х2 (т)), причем в силу предположения

(1.12) множества Zi (t*),Z2 (т*)не пересекаются и разделимы плоскостью.

По этой причине Rz иногда называют спрямляющим пространством, и роль

нейронной сети сводится, по существу, к преобразованию исходных

множеств сложной конфигурации к линейно-разделимым множествам. Не

следует думать, что возможность ’’спрямить” исходные множества является

исключительной. На самом деле для любых непересекающихся ограничен-

ных множеств, разделенных положительным расстоянием, существует

конечный набор пороговых функций, отображающий их в линейно-раздели-

мые множества. Коэффициенты разделяющей плоскости должны

удовлетворять неравенствам (1.13).

18

Другой возможный способ аппроксимации функций (1.12) состоит в

задании распределения вероятностей F на семействе подмножеств множест-

ва /Vи требовании минимизировать функционал

/(т) = /1 (т,а(х))-/(х) I2 F (dx). (1.15)

С помощью найденного из этого условия вектора т получаем разбиение

(1.11), которое, вообще говоря, не обязано совпадать с требуемым, по-

скольку может оказаться, что т =# тф. В приложениях такой подход, тем не

менее, часто приводит к удовлетворительным результатам.

Особенность задачи обучения состоит в том, что распределение F обычно

неизвестно и воспользоваться непосредственно соотношением.

gradJ(r) = O (1.16)

для определения вектора т невозможно. Однако предполагается, что

обучающая последовательность порождается распределением F (точнее,

векторы xf являются случайными, стохастически независимыми и имею-

щими одинаковое распределение вероятностей F). Такое предположение

позволяет в принципе восстановить с помощью обучающей выборки

(достаточно большого объема) с необходимой точностью распределение F

и тем самым открывает возможность построения различных процедур

обучения. Наиболее широкую известность получили стохастически градиент-

ные по отношению к функционалу (1.15) процедуры, имеющие вид

7/+1 = Tt ~ Ъ 1(тг,а (х,)) -/(х,)] а (хг), (1.17)

где yt — подходящим образом подбираемая последовательность неотрица-

тельных чисел. Выражение при yt в (1.17) пропорционально градиенту по т

от подынтегральной функции в (1.15), вычисленному в случайной точкехг.

Процедуры типа (1.17),называемые процедурами Роббинса - Монро, воз-

никли в математической статистике в рамках метода стохастической ап-

проксимации (MCA) для нахождения корней уравнения регрессии, роль

которого в данном случае играет (1.16). При неограниченном объеме

выборки и ряде других предположений удается установить сходимость

оценок Tt к вектору т, минимизирующему функционал (1.15). В рамках

задачи обучения алгоритм (1.17) можно интерпретировать как процедуру

обучения. Реализация этой процедуры обучения не связана с необходи-

мостью восстанавливать в каком-либо виде распределение F й удобна при

использовании быстродействующих ЭВМ.

б) Вероятностная постановка задачи обучения. Если требуемое разбиение

не входит в семейство (1.11), то неравенство (1.13) неразрешимо и реализа-

ция требуемого разбиения с помощью семейства разбиений (111) принци-

пиально невозможна. Однако можно поставить задачу определения в семей-

стве разбиений (1.11) такого, которое возможно меньше отличалось бы от

требуемого. Уточним постановку задачи. Пусть Х2 ~ некоторое разбие-

ние множества X на два непересекающихся подмножества. Обозначим через

Zif Z2 образы множеств XlfX2 при отображении (1.14). Нас будет интере-

совать случай, когда множества Zlf Z2 пересекаются, т.е. заведомо не

являются линейно-разделимыми. Предположим, что в Xвыделена о-алгебра

подмножеств (содержащая Xit Х2), и на этих подмножествах определено

19

распределение вероятностей F. Введем функцию Р(Хх I z) по формуле

(118)

где/)е (z) - шар радиуса е с центром в точке z и {z(x)E/)e (z) }- множест-

во всех х, для которых имеет место включение z (х) в De (z). Предполагает-

ся, что написанный предел существует при всех zG.ZxV Z2. Функция

Р(Хх | z)имеет смысл вероятности того, что точке z=z(x) соответству-

ет xG Xlf и называется степенью достоверности соответствия z первому

классу.

Задача состоит в наилучшей аппроксимации степени достоверности

P(Xi iz)c помощью линейной функции (т, z)b смысле минимизации

функционала

J(r) = /|(r,z(x))-P(X1 |z)i2 F(dx),

(1.19)

т.е. в определении вектора т = argmin J (т). Такая постановка задачи обуче-

ния называется вероятностной.

Если вектор т из этого условия определен, то классификация может

осуществляться, например, по правилу: при наблюдении z (х) сигнал х отно-

сится к первому классу, если (т, z (х)) > й , и ко второму классу в против-

ном случае. Такое правило является оптимальным, если потери от ошибок

классификации не зависят от выбора сигнала х. При наличии такой зависи-

мости оптимальное правило имеет более сложный вид и зависит от соответ-

ствующих значений штрафов за ошибки классификации.

В детерминистской постановке задачи обучения Р(Х^ I z) = 1 при z €

GZi (тф),/,(Аг1 | z) = 0 приzGZ2(t\), и функционал (1.19) несущественно

отличается от (1.15), так что для определения оценок rt можно восполь-

зоваться алгоритмом (1.17), в котором вместо f (хг) используются величи-

ны P(A\ |z) = 2-1 [1 +/(xf)]. В вероятностном варианте задачи величина

Р(Хх | z) может принимать произвольные значения из интервала [0, 1] и

’’указания учителя” не позволяют определить значения Р (Xj I zt) на элемен-

тах обучающей последовательности.

Введем характеристическую функцию s (х) множества Х{:

{1, если x€Xlt

О, если хЕХ2.

Тогда (xt) можно интерпретировать как ’’указание учителя” о принадлеж-

ности сигнала xt множеству Xi (s (xt) = 1) или Хг (s (xt) = 0). Вместо проце-

дуры (1.17) для векторов rf, оценивающих вектор argmin J (т), можно

использовать процедуру т

rt +1 = rt - yt [(Tf, a (xf)) - s (xr)] a (xf), (1.20)

где yt - некоторые неотрицательные числа. При определенных условиях

последовательность {Tt} оказывается сходящейся (при неограниченном

возрастании^ объема обучающей последовательности) к вектору т-

= argmin J (т). Это неудивительно, если заметить, что величины = s (хг) -

20

- Р(Хх | z (xf)) в силу (1.18) удовлетворяют условию М | х[ “ 1) = 0, т.е.

’’указания учителя” s (xf) совпадают с величиной Р (А\ | z (xf)) с точностью

до условно центрированной помехи {£г} . С той же точностью процедура

(1.20) аналогична процедуре Роббинса - Монро (1.17), а наличие помехи

{lt} не сказывается на доказательстве сходимости Tt к т.

В теоретическом плане полное решение задачи обучения состоит в уста-

новлении условий, при которых система (после завершения процесса обуче-

ния) приобретает способность производить высококачественную классифи-

кацию предъявляемых ей входных сигналов. Для процедур (1.17), (1.20)

такие условия обычно должны обеспечивать сходимость оценок rt к т в

том или ином смысле.

1.1.7 °. Задача самообучения. В предыдущем пункте обучение в стохасти-

ческом варианте задачи сводилось к построению последовательности {rt},

минимизирующей функционал (1.19). Процедуры построения оценок

используют ’’указания учителя”. Оказывается, возможно аналогичным

образом поставить задачу обучения, в которой необходимости в таких

указаниях нет, а сам процесс обучения сводится к определению последова-

тельности {rf} , минимизирующей функционал специального вида.

Задача самообучения тесно связана с задачей автоматической классифи-

кации и является обобщением последней на случай неизвестного распреде-

ления, определяющего статистику показа классифицируемых сигналов.

Поэтому до постановки задачи самообучения целесообразно описать задачу

автоматической классификации.

а) Автоматическая классификация входных сигналов. Содержательный

смысл автоматической классификации состоит в построении правила, сопос-

тавляющего каждой точке х множества X некоторый образ (класс). Подра-

зумевается, что тонки, которым сопоставлен один и тот же класс, обладают

некоторым общим свойством, и именно это свойство порождает образ.

Таким свойством, например, может быть близость расположения точек к

некоторому ’’центру”, и тогда понятие образа (класса) отвечает нашим

представлениям о компактном расположении точек, принадлежащих тому

или иному классу.

Правило классификации может быть однозначным или детерминирован-

ным (каждой точке х сопоставляется вполне определенный класс) либо

недетерминированным (точке х сопоставляется набор функций, определя-

ющих степень достоверности соответствия х каждому из классов). Будем

предполагать, что число N классов фиксировано.

Итак, правило классификации основано на введении функций Д1 (х),...

.. ., Мдг (х) - степеней достоверности, обладающих свойствами

N

2 дНх)=1. (1.21)

k = 1

Каждая из функций цк (х) определяет образ (класс) как ’’размытое мно-

жество”, если принимает значения не только 0 и 1. При такой интерпретации

степеней достоверности детерминированная классификация осуществляется

в том специальном случае, когда функции {д* (х)} являются характеристи-

ческими (т.е. принимают лишь значения 0 и 1), т.е. в силу (1.21) каждой

точке х € X однозначно сопоставлен образ, для которого дЛ (х)= 1.

21

Всякий способ классификации связан с ’’потерями”. Будем потери

характеризовать с помощью "штрафных функций"qk (х, т), Л = 1,. . . , /V,

зависящих от векторного параметра т = col (И1 \ , И^). Векторы т

удобно интерпретировать как ’’центры классов”: в типичных случаях X = R

и функции qk (х, т) возрастают при удалении х от центра соответствующего

класса.

Предполагая, что в X выделена о-алгебра подмножеств, на которых опре-

делено распределение вероятностей F, можем вычислить средние потери

классификации, определяемые набором д ( • ) = (д! (•),..., Дуу (•)) и зна-

чениями центров классов:

N

W(r,fi) = f 2 qk(x, r)gk(x)F(dx).

X k = 1

(1.22)

Формальная постановка задачи автоматической классификации состоит в

определении наборов т = col (И1 \ ., т(ЛГ)), Д (•) = (Д1 (•),..., Ддг ( •)) из

условия минимума функционала (1.22) .Минимизация осуществляется в

классе произвольных точек G Rz и функций рк (х), удовлетворяющих

условиям (1.21).

Функционал (1.22) допускает упрощение задачи: для фиксированного

набора т экстремизация функционала осуществляется просто. Действитель-

но, рассмотрим величину

N

^(д)= 2 Qk(x,r)pk(x) (1.23)

к = 1

при фиксированных х иг. При варьировании функций рк (х), удовлетворяю-

щих (1.21), величина И'(д) пробегает выпуклую оболочку точек qk (х, г).

Пусть s - индекс, s = s (х, т), для которого

qs (х, т) = min qk (х, т).

к

Тогда, очевидно, min W(д)достигается на наборе д(), для которого

ps (х) = 1, рк (х) = 0, к Ф 5. Таким образом, экстремальный набор д ( •) име-

ет вид

где (х, т) - характеристическая функция

(х, т) =

1,

.0,

если к = s (х, т),

если к Ф s (х, т).

(1-24)

Учет этого обстоятельства позволяет функционал (1.22) рассматривать

только как функцию набора т центров классов

N

2 qk(x,r)J^(x, r)F(Jx). (1.25)

X к~ 1

Функционал (1.25) будем называть функционалом среднего риска в задаче

самообучения.

22

Характеристические функции (1.24) определяют замкнутые множества

Хк (г)» объединение которых совпадает сХ. Нам удобнее множества Хк (т)

рассматривать как непересекающиеся, для этого условимся относить гра-

ничные точки к множеству с меньшим индексом, т.е.

^*(T)=[ n {qk(x,r)<

/ < *

< Q) <х, т) } ] П [ О {qk (х, т) <q, (х, т)} ].

/ > fc

(1.26)

Значение функционала (1.25) от этого не изменится, но множества (1:26)

уже образуют TV-разбиение X (т.е. Х{ (т) И Х{- (т) = ф, i j, и Х( (т) = X).

i - 1

Итак, задача автоматической классификации в принятой постановке

сводится к определению TV-разбиения пространств а X из условия минимиза-

ции функционала (1.25).

Отметим, что функционал (1.22) приводит к ’’чистым стратегиям” клас-

сификации: оптимальный набор д ( • ) = (д i (•),..., ( • )) состоит из

характеристических функций, что соответствует однозначной классифи-

кации. Если вместо (1.22) принять функционал

/V

W (т, д) = f S qk (х, г) | цк (х) |z F (dx)

х к = 1

при некотором Z =# 1, то оптимальная классификация может иметь вид

’смешанной стратегии”, т.е. не будет однозначной.

б)Геометрическая интерпретация задачи автоматической классификации.

Поясним смысл формально описанной выше задачи автоматической класси-

фикации. Пусть X = Rz и

gfc(x, 7) = |х-т(*)Г, (1.27)

где 7 = col (И1 \ . . . , 7^), | х| - норма вектора х Разбиение ^1.26) относит

тогда к множеству Хк (т) все точки х, которые находятся к т^ ближе, чем

к любому из центров т'*' при s^k, т.е. разбиение (1.26) полностью опреде-

ляется заданием векторов {т^} , s = 1,... ,7V. Интеграл

f I х - т(*> |* F (dx)

(T)

определяет рассеяние точки x в множестве Xk (т), а функционал (1.25)

имеет смысл суммарного рассеяния по всем множествам {Хк (т)} . Таким

образом, задача автоматической классификации при функциях (1.27)

состоит в определении центров {т^} , при которых суммарное рассеяние

минимально.

Искомый набор центров должен удовлетворять уравнению

grad И7(т) = 0 , т = col (7^\ . . ., т^). (1.28)

Нетрудно убедиться, что для функций (1.27) множества Хк (7), определяе-

мые условиями (1.26), имеют вид многогранников, а центры т<*\ опреде-

23

ляемые из (1.28), совпадают с их ’’центрами тяжести”, т.е.

т(л)=[Е{Хл(т)}]’1 S х F(dx). fc=l,...,M

xk(r)

причем центры тяжести соседних множеств находятся на прямой, ортого-

нальной разделяющей множества грани.

Приведенные соображения, относящиеся к функционалу (1.25), (1.27),

отвечают интуитивному представлению о компактности разбиения множест-

ва Xна ТУнепересекающихся классов.

в)Связь задачи самообучения с рекуррентным оцениванием. К задаче само-

обучения приходим в случае, если распределение вероятностей F неизвестно

и воспользоваться уравнением (1.28) невозможно, но предполагается

известной ’’обучающая” последовательность, порождаемая этим распре-

делением.

Для получения оценки rt неизвестного вектора т тогда можно восполь-

зоваться рекуррентной процедурой, стохастически градиентной к функцио-

налу (1.25). В данном случае имеем

N

тг+1=т> —7г 2 Aft(Tf)(xf)gradT<?fc (xt,Tt), (1.29)

где через JXk (х) обозначена характеристическая функция множества Хк и

{ yt}- некоторая последовательность неотрицательных чисел. При N> 1

процедура (1.29) отличается от процедуры Роббинса - Монро наличием в

ней характеристических функций, что осложняет исследование сходимости

полученных оценок. Это усложнение связано еще и с обычной неединствен-

ностью решений уравнения (1.28), причем далеко не каждое его решение

доставляет минимум функционалу (1.25). Тем не менее, процедура (1.29)

наследует многие особенности процедуры Роббинса - Монро, а при N =

= 1 совпадает с ней.

Таким образом, решение задачи обучения в принятой трактовке вновь

свелось к установлению условий сходимости рекуррентной процедуры оце-

нивания параметров — искомых ’’центров классов”.

1.1.8°. Идентификация динамического объекта. Предположим, что

объект управления (ОУ) описывается в дискретном времени t = 1,2,...

уравнением

a$)yt = b(V)ut + vt. (130)

Здесь yt - выход ОУ ; ut - вход ОУ (управляющее воздействие) ; vt - воз-

мущающее воздействие (помеха) ; V - оператор сдвига на такт назад: Vуt =

-yt - i, Vut -ut_. i; я (X) = 1 +ХД1 + ... + Xr ar, b (X) = . +Xr br,

I ar I + I br I Ф 0; r - натуральное число (порядок разностного уравнения

(1.30) ). Вещественные коэффициенты полиномов а (X), b (X) предполагают-

ся неизвестными. Требуется по наблюдениям за входами { ut} и выходами

{yt } оценить значения этих коэффициентов.

Вводя обозначения

7 = COl(0j . . . . ,0Г, />!,... ,br), (1.31)

Ф, = со!(- >7,.. . , -yt_r+iiut,. . . ,1О-г+1),

24

соотношение (1.30) перепишем в виде

_г, + 1 =Ф,’ T + Uf + 1, (1.32)

где Фг’т можно интерпретировать как полезный сигнал, линейно зависящий

от неизвестного вектора параметров т. Этот сигнал наблюдается на фоне по-

мехи. В такой интерпретации задача идентификации (задача восстановления

либо оценивания параметра т) близка к задаче обнаружения сигнала (см.

(1.5)), где роль неизвестного параметра играла скалярная величина 6.

При определенных предположениях о стохастических свойствах помехи

и управляющих воздействий задача идентификации допускает решение и

это решение имеет вид рекуррентных соотношений, доставляющих оценки,

сколь угодно близкие к значению неизвестного параметра йри неограни-

ченном увеличении объема наблюдений.

1.1.9°. Синтез адаптивного управления динамическим объектом. В ряде

приложений приходится решать задачу синтеза обратных связей для управ-

ления объектом (1.30) в условиях, когда некоторые из его параметров

(коэффициентов полиномов а(Х),Ь(Х)) неизвестны. Хотя, возможно,

при известных значениях параметров ОУ задачу синтеза нужных управле-

ний мы и можем решить, непосредственно воспользоваться этим результа-

том синтеза невозможно, поскольку построенный закон формирования

управлений может оказаться зависящим от неизвестного вектора пара-

метров т. Естественной является идея о совмещении алгоритма иденти-

фикации динамического объекта с построенным законом формирования

управлений: использовать в этом законе вместо неизвестного вектора г

текущую оценку тг, получаемую в процессе идентификации. Если такой

способ позволяет обеспечить поставленную цель управления, то управляю-

щую систему естественно назвать адаптивной по отношению к этой цели.

(Кроме того, адаптивная система характеризуется классом адаптации -

множеством возможных значений неизвестного параметра и классом по-

мех, при которых описанный выше процесс управления обеспечивает

выполнение цели управления.) Внешне рассматриваемая задача адаптивно-

го управления совпадает с описанной в п. 1.1.8° задачей идентификации,

и действительно, между ними имеется тесная связь. Однако, как известно,

проблема идентификации замкнутых систем управления достаточно слож-

на, поскольку процессы идентификации и управления в некотором смысле

противоречивы: чем выше качество управления, тем обычно хуже идет

процесс идентификации. Управления, формируемые обратными, связями,

могут не обладать достаточным ’’разнообразием”, что не обеспечит эффек-

тивности процесса идентификации. Поэтому задача адаптивного уп-

равления отнюдь не исчерпывается задачей идентификации и далеко не

всегда к ней сводится.

1.1.10° Отслеживание дрейфа экстремума нестационарного функцио-

нала. Важной для приложений является следующая задача. Пусть Qt( т) -

случайная функция времени t и случайного параметра т, принимающего

значения из R^. Обозначим через qt(r) функцию регрессии

<7г(т)=М{(?г(т)1т}, (1.33)

где справа стоит условное среднее. Точку минимума qt(т) обозначим

т*г = argmin qt(j) . (134)

25

Требуется по наблюдениям за случайными величинами Qt(r) (либо

gradT(?r(r)),z =0, 1,, построить алгоритм оптимизации, определяющий

последовательность {тг}, для которой (при t -*°°) в каком-

либо смысле.

Описанная задача отслеживания дрейфа экстремума возникает, например,

в задаче адаптивного управления, если параметры объекта и показатель ка-

чества управления изменяются во времени. Задача (1.34) является пред-

метом рассмотрения в теории экстремальных систем управления и динами-

ческих алгоритмов оптимизации.

Успешное решение задачи отслеживания дрейфа экстремума связано с

предположениями о характере дрейфа и стохастических свойств функции

Qt(r) или ее градиента. Часто принимается, что изменение во времени

экстремальной точки происходит по степенному закону (полиномиальный

дрейф), т.е. определяется соотношением

т

= S aktk (1.35)

fc = 0

с неизвестными (подлежащими оцениванию) коэффициентами ак. Возможны

и другие законы дрейфа экстремума, определенные с точностью до конеч-

ного набора неизвестных параметроз.

§ 1.2. БАЙЕСОВСКИЕ КРИТЕРИИ

Решение адаптивных задач часто основано на достаточно детальном изу-

чении соответствующих задач в условиях ’’полной информации”. В этом

параграфе изучаются некоторые из оптимизационных задач, связанные с

минимизацией функционала среднего риска в предположении, что необ-

ходимые для вычисления функционала распределения известны. Получен-

ные здесь результаты используются для решения задачи обучения (§ 2.1),

самообучения (§ 2.2) и оптимального обнаружения сигнала (§ 2.3).

1.2.1°. Функционал среднего риска. Широкий класс задач математичес-

кой статистики связан с минимизацией функционала, называемого средним

риском. С достаточной для наших целей общностью такой функционал

может быть введен следующим образом.

Предположим, что в пространстве П элементарных событий выделено N

N

непересекающихся событий ,..., П^, П = U Пр Пусть х = х (со ) - с.в.

со значениями в евклидовом пространстве Rz размерности / и х(П,) -

образы событий П, при отображении х : H-*RZ. Конструкция, в рамках

которой вводится функционал среднего риска, предназначена для ’’опти-

мального” разбиения пространства Rz на N непересекающихся подмно-

жеств в смысле соответствия этого разбиения событиям{х(П,)}. Уточним ха-

рактер этого соответствия.

Предположим, что в Rz выделено семейство множеств {АС/(О)/=ь кото-

рое определяется параметром £ со значениями из некоторого множества

Z, т.е. при каждом | G Z множества Xy(f), / = 1,2,. .., TV, являются ^раз-

биением пространства Rz. Кроме того, предположим, что на множестве

Rz X S заданы вещественные функции qj(x, = 1,2,..., /V, называемые

26

Лх(х) =

весовыми. Введем функционал

H'«) = /<2(x(co),Ot/P, (2.1)

где Р — вероятностная мера, определенная на а-алгебре подмножеств

(событий) пространства Q,

N

<20и)=Д (2.2)

/у(х) - индикатор множества X :

1, если х Е X ,

О, если х (£ X.

Разбиение {У,(£))/!I назовем байесовским {оптимальным в классеН),

если параметр £ разбиения определен из условия минимума функциона-

ла (2.1).

В теории принятия решений весовые функции q^x, £) конкретизируют-

ся, функционал (2.1) при этом имеет смысл средних потерь (среднего

риска). Этого же названия мы будем придерживаться и в общем случае.

Наименьшее в множестве Z значение функционала (2.1) иногда удобно

интерпретировать как количественную характеристику качества аппрокси-

мации множеств (х(П,)} Д с помощью семейства множеств {Х/(£)} 7= >.

Сложность решения задачи байесовского разбиения пространства Rz за-

висит от свойств весовых функций и семейства разбиений. Множество

параметров Z может быть подмножеством конечномерного евклидова

пространства и в этом случае минимум функционала среднего риска может

быть найден с помощью известных методов анализа, основанных на иссле-

довании стационарных точек функции W(£) векторного аргумента £. В

других случаях Z - функциональное пространство, элементами которого

являются функции, определенные на Rz. Эти функции обычно имеют смысл

дискриминантных (разделяющих), так как с их помощью осуществля-

ется реализация семейства разбиений {Xj($)h=i •

Перейдем к описанию некоторых задач, связанных с функционалом

среднего риска.

1.2.2°. Автоматическая классификация изображений. Под автоматичес-

кой классификацией изображений понимают процедуру, которая по изме-

ренным значениям признаков изображений (в качестве последних мо-

гут выступать сигналы, стимулы, объекты произвольной природы)

производила бы их классификацию, т.е. относила изображения к опре-

деленным классам. Множество изображений удобно отождествить с

пространством Q элементарных событий, а набор признаков х рассматри-

вать как значение с.в.х(со)со значениями в Rz. Классами изображений

в этом случае выступают события Qi,. . ., £2дг, образующие разбиение

пространства П на N непересекающихся подмножеств (А-разбиение прост-

ранства П).

Белив Rz задано семейство {Х/Й)} Мразбиений, то процедуру клас-

сификации принимают в следующей форме: при некотором фиксирован-

ном £ 6 Z произвольное изображение со относится к /-му классу (иногда

говорят, что принимается гипотеза со G Q,), если х(со) G Х,(£). Такой спо-

27

соб классификации может оказаться неудачным, если для выбранного па-

раметра $ разбиение{А\(£)};=1 плохо соответствует набору множеств

{х(Ц)}Д1 и, следовательно, в результате такой классификации порождает-

ся большое число ошибок. Выбор подходящего параметра £, преследующий

цель уменьшить число ошибок при классификации, связан с учетом как

статистики распределения изображений по классам изображений, так

и со значимостью тех или иных ошибок. Традиционный подход к за-

даче классификации, учитывающий эти особенности, состоит в следую-

щем.

Обозначим через D€(x) шар радиуса е с центром в точке х Е Rzh пред-

положим, что при любом х существуют пределы

P(fi,lx)= lim P[{x(w)G£>e(x)} П Я,ЦР{х(и))еОе(х)}]’’. (2.3)

Е-0

Величина Р(£2,1х) характеризует вероятность появления изображения / -го

класса при фиксированном векторе признаков х и называется апостериор-

ной вероятностью появления класса Ц для данного х. Предположим так-

же, что задана матрица штрафов II II, элемент cif- которой обозначает

потери, производимые при отнесении к классу Ц изображения из класса

П/. Теперь можно вычислить средние потери по всем изображениям, если

классификация будет производиться с помощью разбиения {Vz(^)}% j: они

имеют вид (2.1) при

N

= 2 СОР(Ц 1х), (2.4)

/-1

т.е, в рассматриваемом случае весовые функции от параметра £ не зави-

сят.

Если семейство {Х/О;)}^! соответствует всевозможным yV-разбиениям

пространства Rz, то задача минимизации функционала (2.1), (2.4) решает-

ся просто. Действительно, с учетом (2.4) функционал (2.1) можно записать

в виде

N N

2 - с0Р(Ц lx)l F(Jx), (2.5)

/= 1 /= 1

где F - распределение вероятностей, порождаемое в Rzc.b.x(oj), т.е. F

для любого борелевского множества А определяется соотношением

F{4} = P{x(cj) ЕЛ}. Из (2.5) следует, что байесовское разбиение {Xj}

определяется условиями

N N

Xs = {х : min 2 С;уР(Ц1х)= 2 с^Р(Ц1х)), (2.6)

i /=1 /=1

X

т.е. вектор х относится к множеству Xs, если величина 2 1х) ,

i= 1

i = 1,2,.. ., ЛУ, принимает наименьшее значение при / = s. Для определен-

ности условимся, что граница множеств X, , Х{- при i < j относится

к множеству Л', . Отметим, что в соответствии с формулами Байеса апо-

28

стериорные вероятности Р (О/1 х) могут быть представлены в виде

PiP(x IQ.)

Р(Ц- 1х) = ... ' , (2.7)

Р(х)

где

Р/ = Р(ЯД

р(х)= Ит

е—О

р{х(со)-еое(х)}

ад

(2.8)

р(х I Slj) = Ит

б—О

Р[{х(ц)ед(х)}п »,]

Pi Уе(х)

Ие(х)- объем шара£)е(х) (предполагается, что написанные пределы су-

ществуют при всех х Е R7). При этом р7 называется априорной вероятно-

стью события Q7 (появления изображения /-го класса), р(х) —плотностью

распределения изображений, р(х I Q7) - условной плотностью изображе-

ний /-го класса.

В теории статистических выводов функции (2.8) принимаются в качест-

ве исходных (доопытных) данных, а функции (2.3) рассматриваются

как результат ’’испытания”. Использование формул (2.7) для определения

оптимального разбиения (2.6) в терминах априорных данных послужило

поводом назвать рассмотренный выше критерий классификации байесов-

ским.

1.2.3°. Автоматическая классификация при неизвестных апостериорных

вероятностях. Рассмотренный в п. 1.2.2° байесовский критерий классифи-

кации изображений основан на использовании апостериорных вероятнос-

тей P(Q7 I х) и предполагает задание матрицы штрафов II с,7 II. В ряде слу-

чаев можно поставить разумную задачу классификации и при отсутствии

этих данных. Предположим, например, что известна лишь плотность р (х)

распределения изображений и число АГ классов, которым могут принадле-

жать изображения. Если множества x(Q7) в достаточной степени ’’раз-

несены” и локализованы около некоторых ’’центров” в R*, то представ-

ляется правдоподобным, Что исследование функции р(х> позволит опре-

делить эти центры и организовать достаточно хорошую процедуру клас-

сификации. Эти наводящие соображения формализуем следующим обра-

зом.

Пусть т(1>(£),. .. , tn(£) - некоторые точки в R7 , которые будем интер

претировать как "центры "множеств Хх (£),. .. , XN(%). Функционал

N

И/(0= s f |x-r(0(^PP(x)dx (2.9)

/=1 хдп

имеет смысл суммы среднеквадратичных рассеяний точек х относительно

центров множеств. В качестве оптимального А-разбиения пространства

Rz выбирается то, для которого функционал (2.4) принимает наимень-

шее в Z значение. Классификация изображений со при найденном разбие-

НИИ{^({))Д1 производится, как и в п. 1.2.2°. Решение задачи минимиза-

29

ции функционала (2.4) упрощается, если