Автор: Шумский С.А.

Теги: наука и знание в целом науковедение организация умственного труда типы и характеристики систем наука кибернетика искусственный интеллект машинное обучение

ISBN: 978-5-369-02011-1

Год: 2019

МАШИННЫЙ ИНТЕЛЛЕКТ

С. А. ШУМСКИЙ

НАУКА И ПРАКТИКА

«МОСКОВСКИЙ ФИЗИКО-ТЕХНИЧЕСКИЙ ИНСТИТУТ

(НАЦИОНАЛЬНЫЙ ИССЛЕДОВАТЕЛЬСКИЙ УНИВЕРСИТЕТ)»

С.А. Шуйский

МАШИННЫЙ

ИНТЕЛЛЕКТ

ОЧЕРКИ ПО ТЕОРИИ МАШИННОГО ОБУЧЕНИЯ

И ИСКУССТВЕННОГО ИНТЕЛЛЕКТА

Москва

РИОР

УДК 001(06)+004.032.26(06) ф3 издание не подлежит маркировке

ББК 72я5+32.818я5 № 436-ФЗ в соответствии с п. 1 ч. 2 ст. 1

Ш96

Художественное оформление обложки — КС. Шумекая

Автор:

Шумский С. А. — канд. физ.-мат. наук, директор Научно-координационного

совета Центра Национальной технологической инициативы по сквозной

технологии «Искусственный интеллект» на базе МФТИ, заведующий лабораторией

когнитивных архитектур МФТИ, президент Российской ассоциации нейроин-

форматики, руководитель направления «Нейроассистенты» дорожной карты

«Нейронет» Национальной технологической инициативы. Автор более 70 научных

публикаций, в том числе пособия по нейрокомпьютингу

Рецензент:

ЖиляковаЛ.Ю. — д-р физ.-мат. наук, ведущий научный сотрудник Института

проблем управления РАН (Москва)

Шумский С.А.

Ш96 Машинный интеллект. Очерки по теории машинного обучения

и искусственного интеллекта/ С.А. Шумский. — М.: РИОР, 2019. —

340 с. - DOI: https://doi.org/10.29039/02011-l

ISBN 978-5-369-02011-1

ISBN 978-5-369-02018-0 (online)

В книге дается обзор современного состояния и перспектив

развития исследований по машинному интеллекту. Предложен подход к

созданию «сильного» искусственного интеллекта с использованием

принципов работы человеческого мозга.

Каждая глава представляет собой самостоятельный очерк, ставящий

и разрешающий актуальные вопросы современности: Какие задачи

предстоит решить на пути совершенствования машинного обучения? Как

машинный интеллект может способствовать технологическому развитию

общества в целом и частного предпринимательства в частности? Чего

можно ожидать от машинного интеллекта в ближайшие 10—15 лет?

Адресована студентам, исследователям и разработчикам

приложений в области искусственного интеллекта, а также всем, кого

интересуют принципы работы мозга с позиций теории машинного обучения.

УДК 001(06)+004.032.26(06)

ББК72я5+32.818я5

Все права защищены. Запрещается копирование, распространение

или любое иное использование информации без предварительного

согласия правообладателя (кроме правомерного цитирования).

ISBN 978-5-369-02011-1 © Шумский С.А.

ISBN 978-5-369-02018-0 (online) © иц РИОР

Оглавление

Глава 1. Пролог 9

1.1. О чем и для кого эта книга 10

1.1.1. О чем эта книга 10

1.1.2. Для кого эта книга 10

1.1.3. Почему это важно 11

1.2. Структура книги 13

1.3. Благодарности 15

Глава 2. Машинный интеллект в современном мире 17

2.1. Машинный интеллект: время пришло? 18

2.2. Преодоление барьера сложности 20

2.3. Новый технологический уклад 23

2.3.1. Новый обильный и дешевый ресурс .... 24

2.3.2. Новый технологический пакет 26

2.3.3. Новая организация рынка 27

2.4. Гонка за искусственным интеллектом 29

2.5. Вызов России 31

Глава 3. Основы машинного обучения 35

3.1. Основные понятия 36

3.1.1. Машинное обучение как наука 36

3.1.2. Разум, интеллект и сознание 38

3.1.3. Машинное обучение: модели 41

3.1.4. Оптимальная сложность моделей 43

3.1.5. Байесова трактовка обучения 45

4

ОГЛАВЛЕНИЕ

3.1.6. Ансамбли гипотез 47

3.1.7. ЕМ-алгоритм 50

3.2. Обучение с учителем: распознавание образов . . 55

3.2.1. Нейрон-классификатор 57

3.2.2. Многослойные персептроны 58

3.2.3. Градиентное обучение 62

3.2.4. Регуляризация обучения 66

3.2.5. Сложность градиентного обучения .... 68

3.3. Обучение без учителя: сжатие информации ... 70

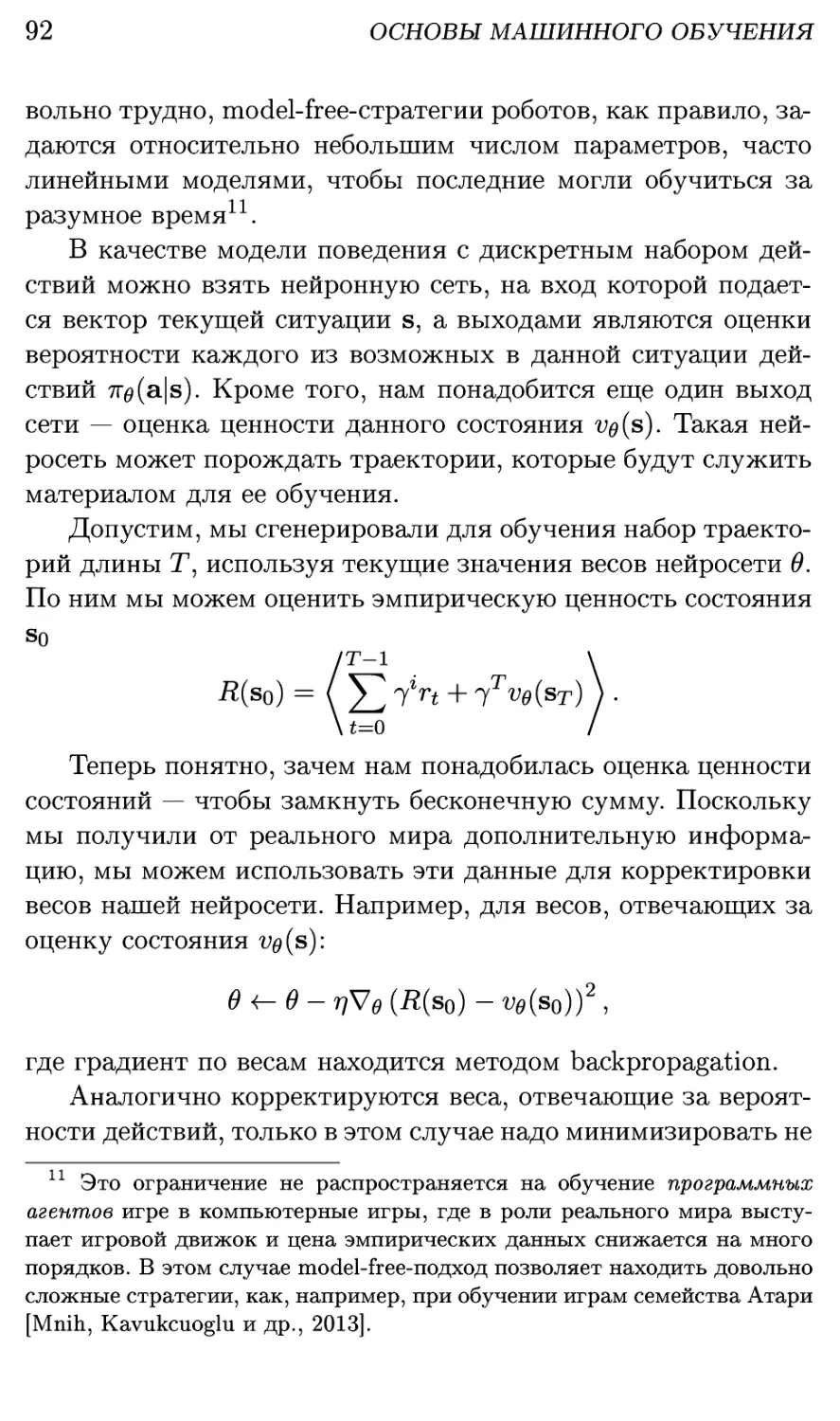

3.3.1. Обобщение данных 71

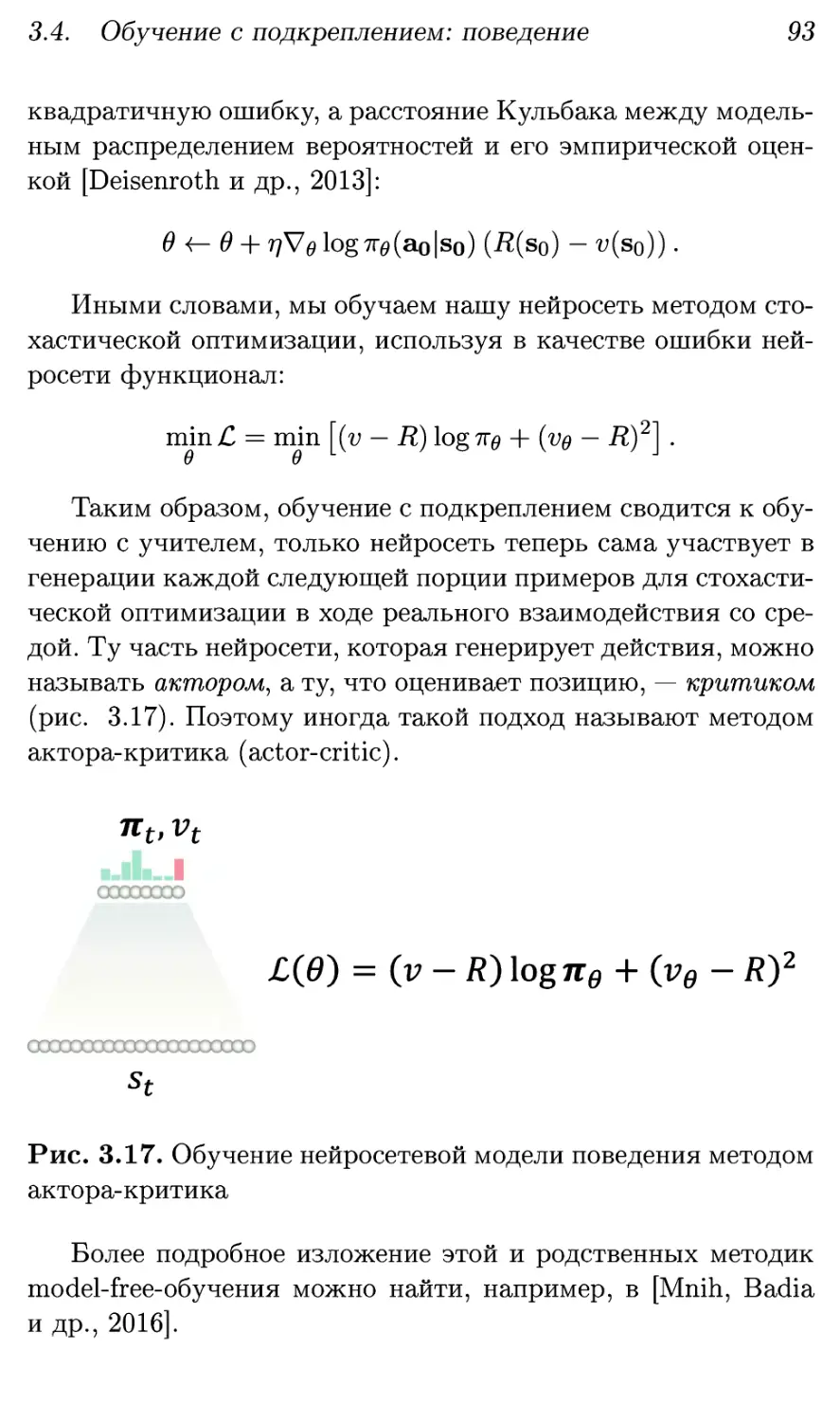

3.3.2. Нейрон-индикатор Хебба 72

3.3.3. Анализ главных компонент 75

3.3.4. Нелинейные главные компоненты 79

3.3.5. Соревнование нейронов 83

3.3.6. Самоорганизующиеся карты 87

3.4. Обучение с подкреплением: поведение 90

3.4.1. Обучение без моделирования среды ... 91

3.4.2. Обучение с моделированием среды .... 94

3.4.3. Связь с теорией управления 96

3.5. Обсуждение 97

Глава 4. Глубокое обучение 99

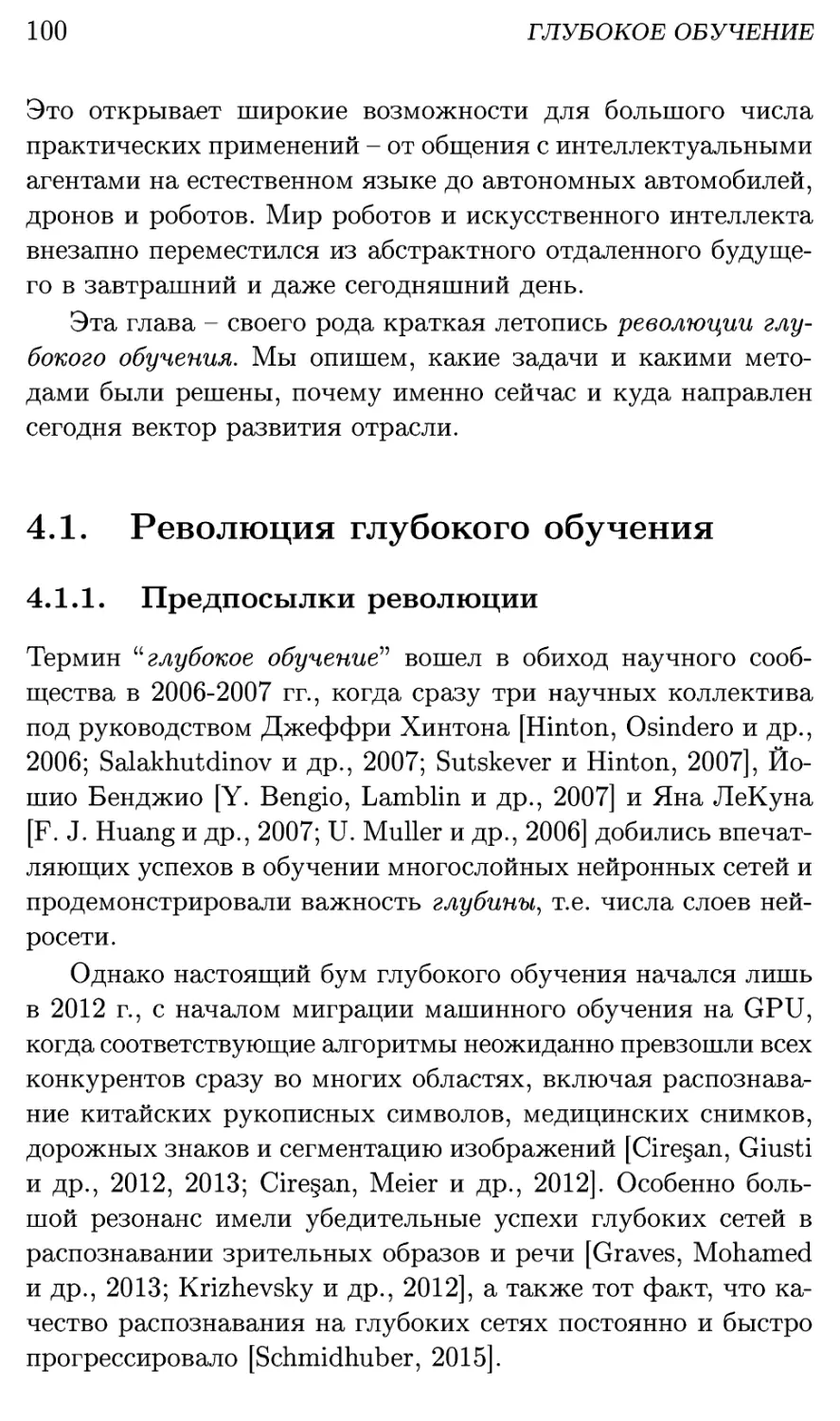

4.1. Революция глубокого обучения 100

4.1.1. Предпосылки революции 100

4.1.2. Суть глубокого обучения 102

4.1.3. Методики глубокого обучения 104

4.1.4. Экстремально разреженные сети 108

4.1.5. Hardware для глубокого обучения 110

4.2. Рекуррентные глубокие сети: речь и язык .... 112

4.3. Сверточные сети: зрение и не только 119

4.4. Transformer: быстро и качественно 123

4.5. Комбинации и синтез модальностей 126

4.6. Реляционные сети: понимание связей 128

4.7. Генерирующие сети: воображение 130

4.8. Обучение с подкреплением: поведение 136

ОГЛАВЛЕНИЕ

5

4.9. Вектор развития: искусственная психика .... 143

Глава 5. Вычислительная архитектура мозга 147

5.1. Реверс-инжиниринг мозга 148

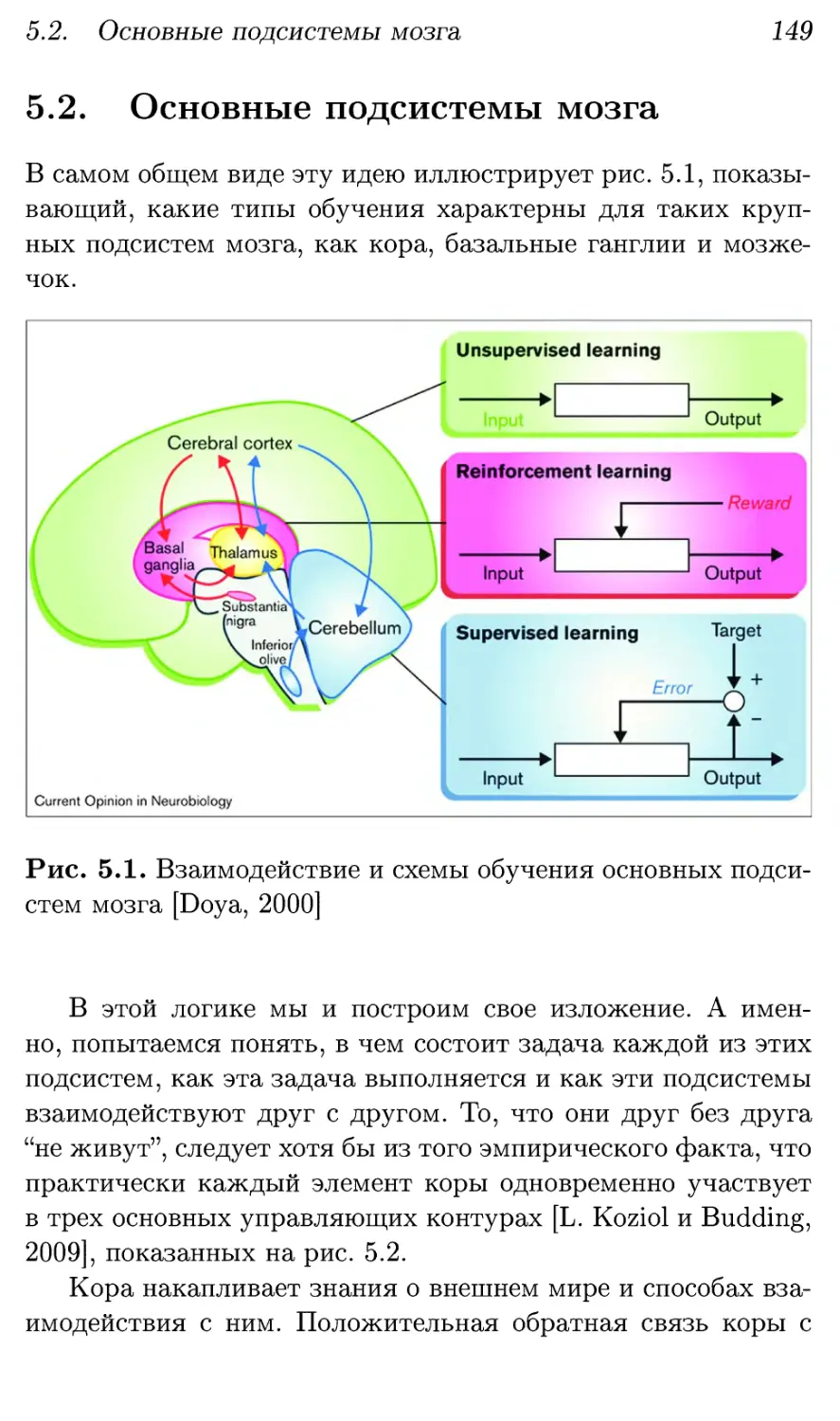

5.2. Основные подсистемы мозга 149

5.3. Кора: ассоциативная память 151

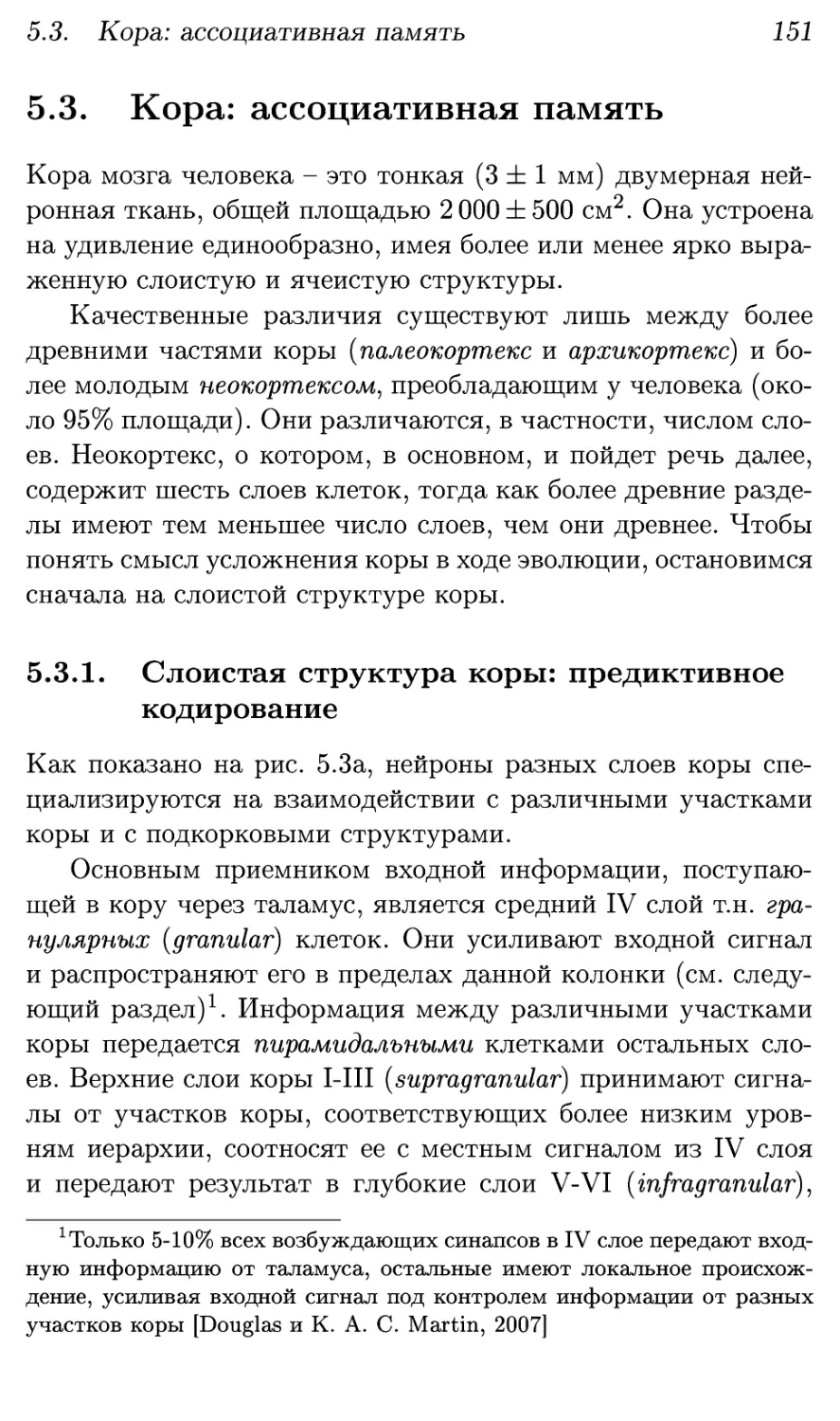

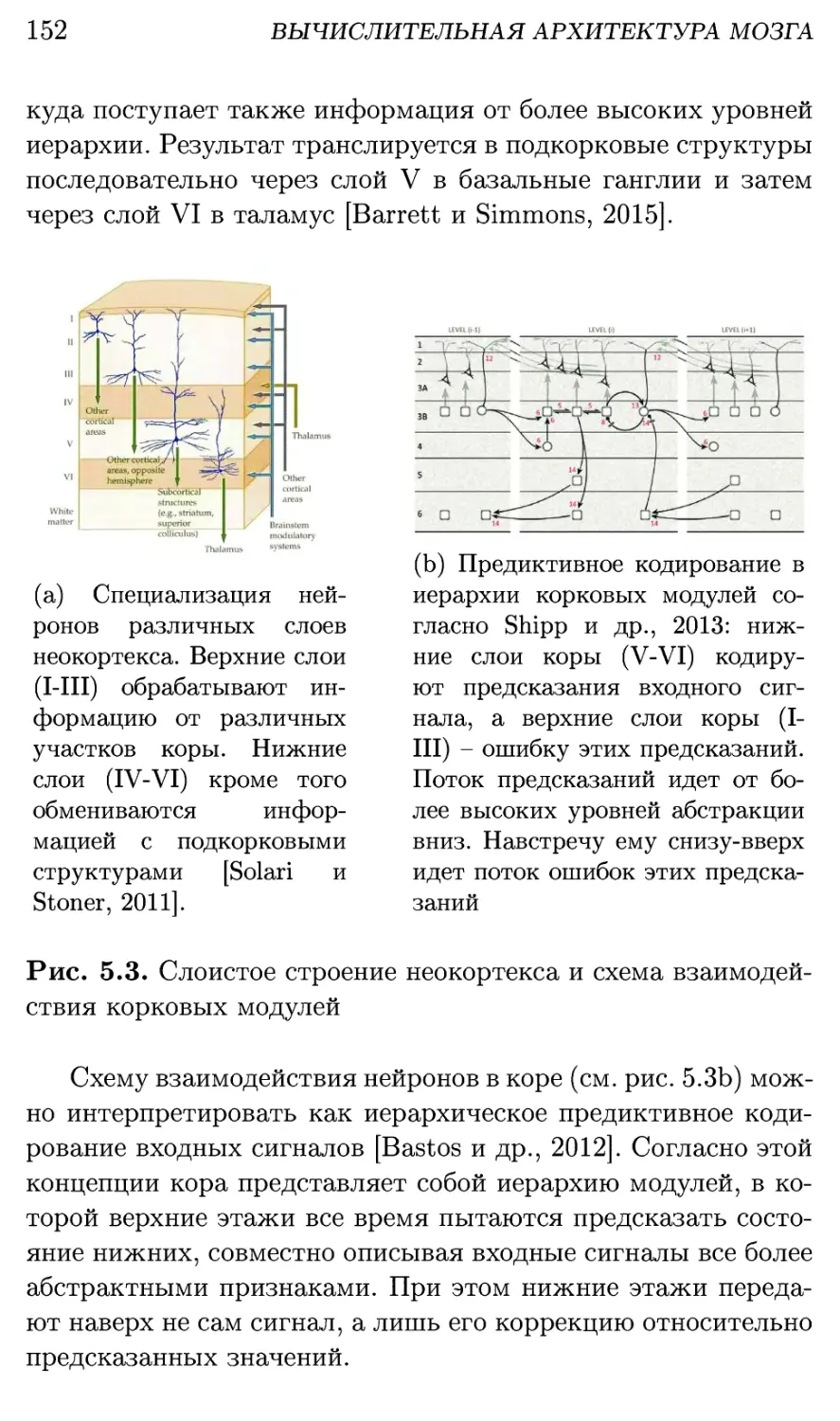

5.3.1. Слоистая структура коры: предиктивное

кодирование 151

5.3.2. Ячеистая структура коры: дискретное

разреженное кодирование 158

5.3.3. Древняя кора: эпизодическая память . . . 162

5.4. Таламус: внимание и связность ощущений .... 167

5.5. Базальные ганглии: принятие решений 169

5.5.1. Управление вниманием 169

5.5.2. Обучение ценностям 173

5.5.3. Контроль активности в коре 177

5.6. Мозжечок: закрепление пройденного 180

5.7. Схемотехника мозга: Deep Control 184

5.8. Deep Control — изобретение приматов 187

5.9. Абстрактное мышление: моделирование 190

5.10. Новая старая архитектура 194

Глава 6. На пути к искусственной психике 199

6.1. Зачем нужна искусственная психика? 199

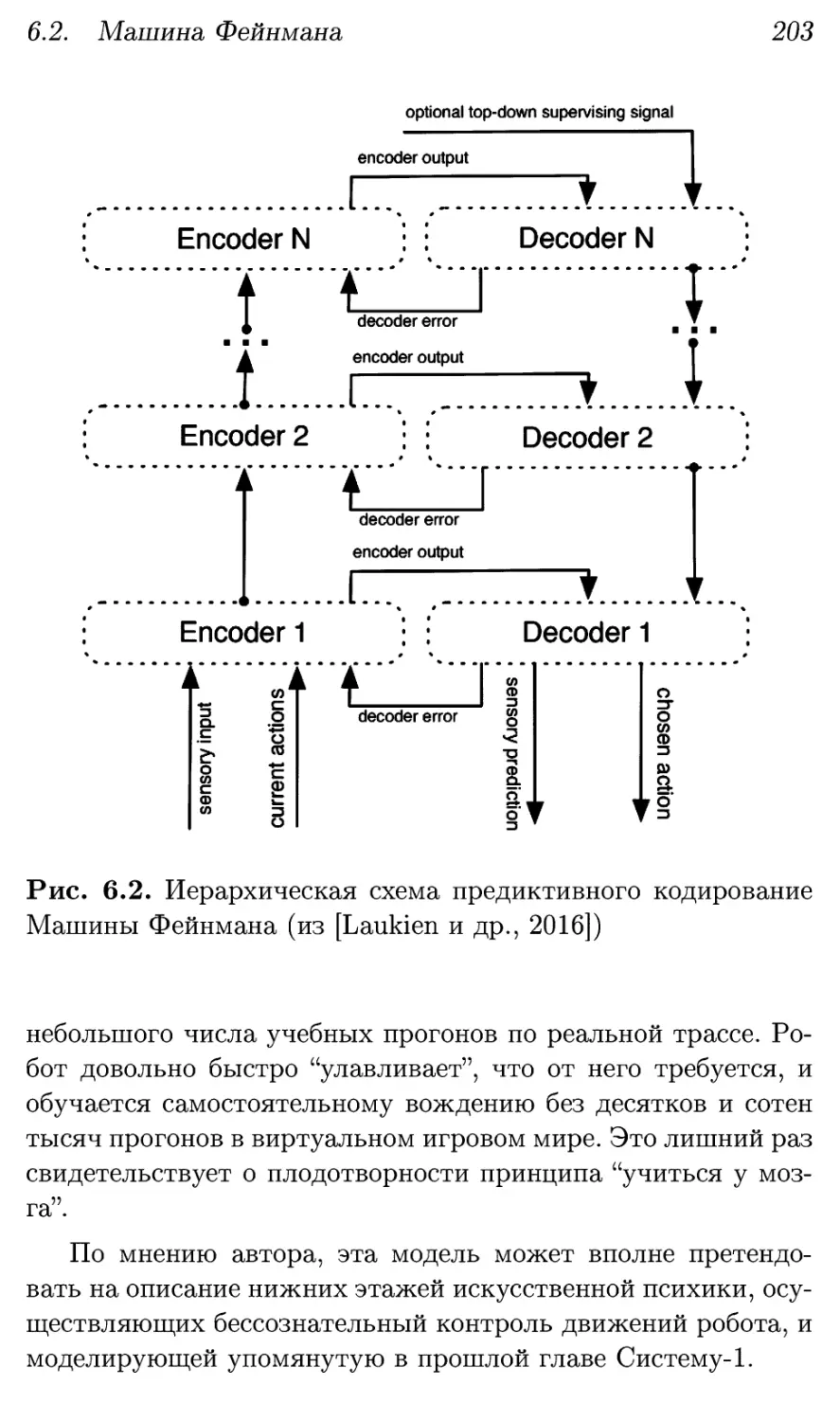

6.2. Машина Фейнмана 201

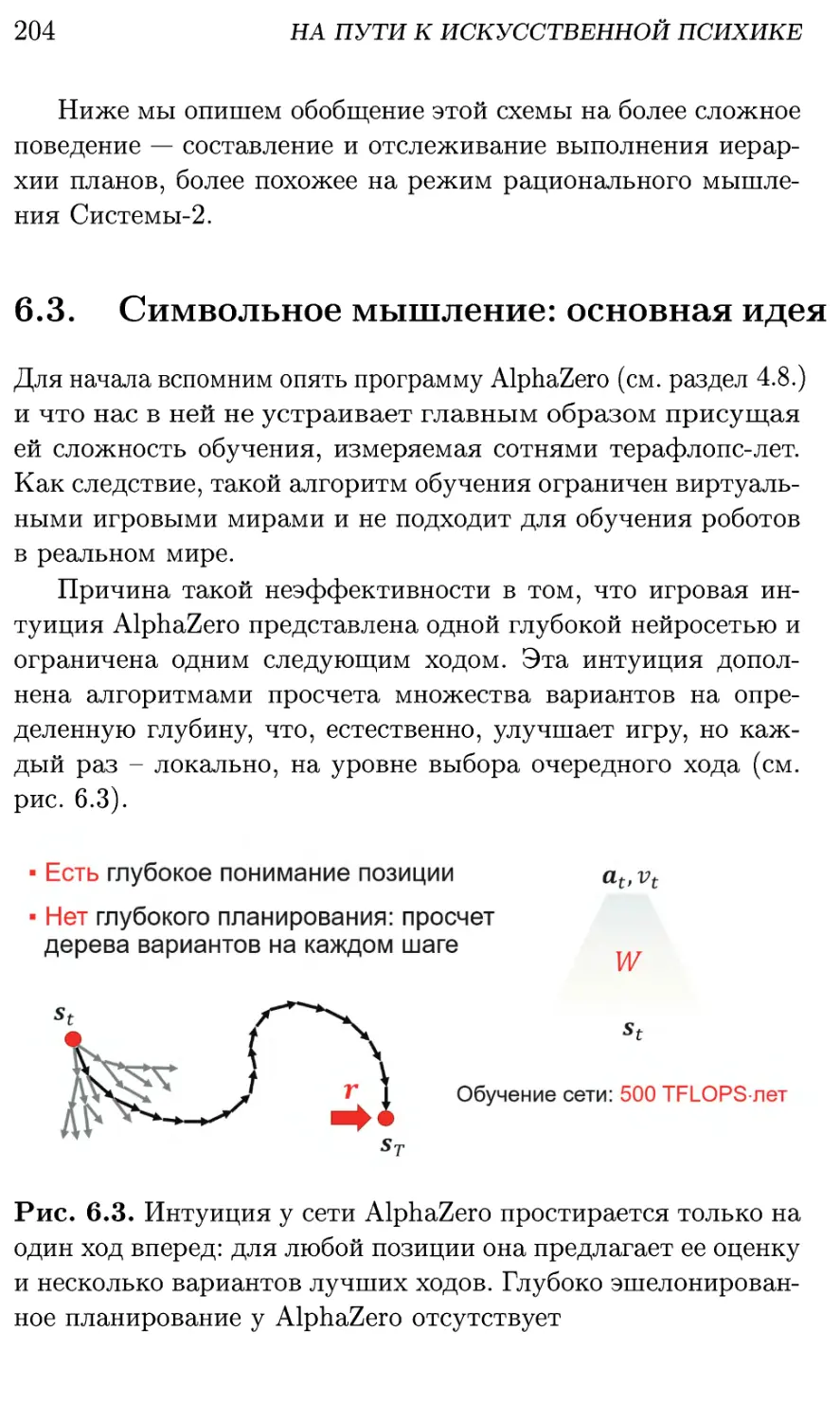

6.3. Символьное мышление: основная идея 204

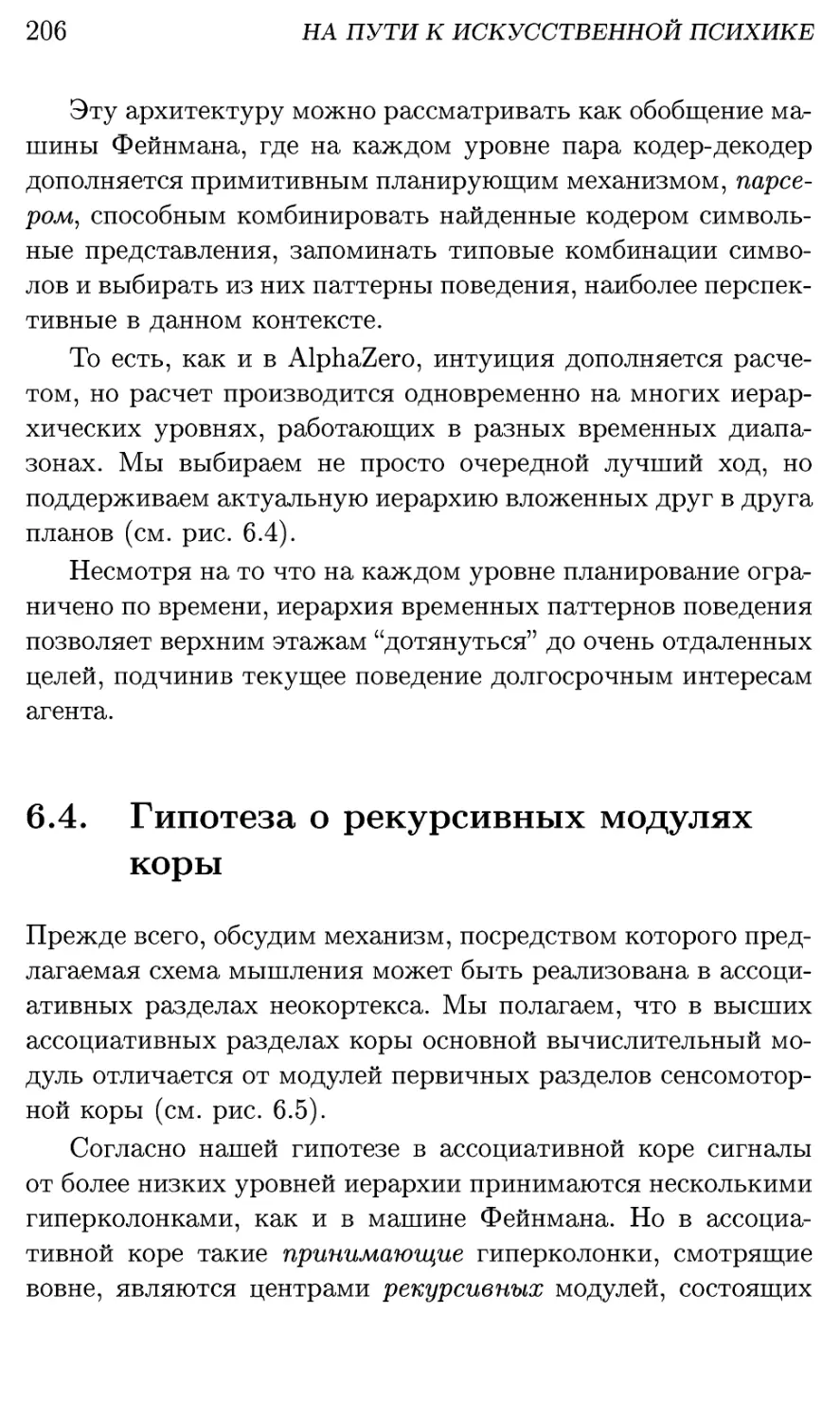

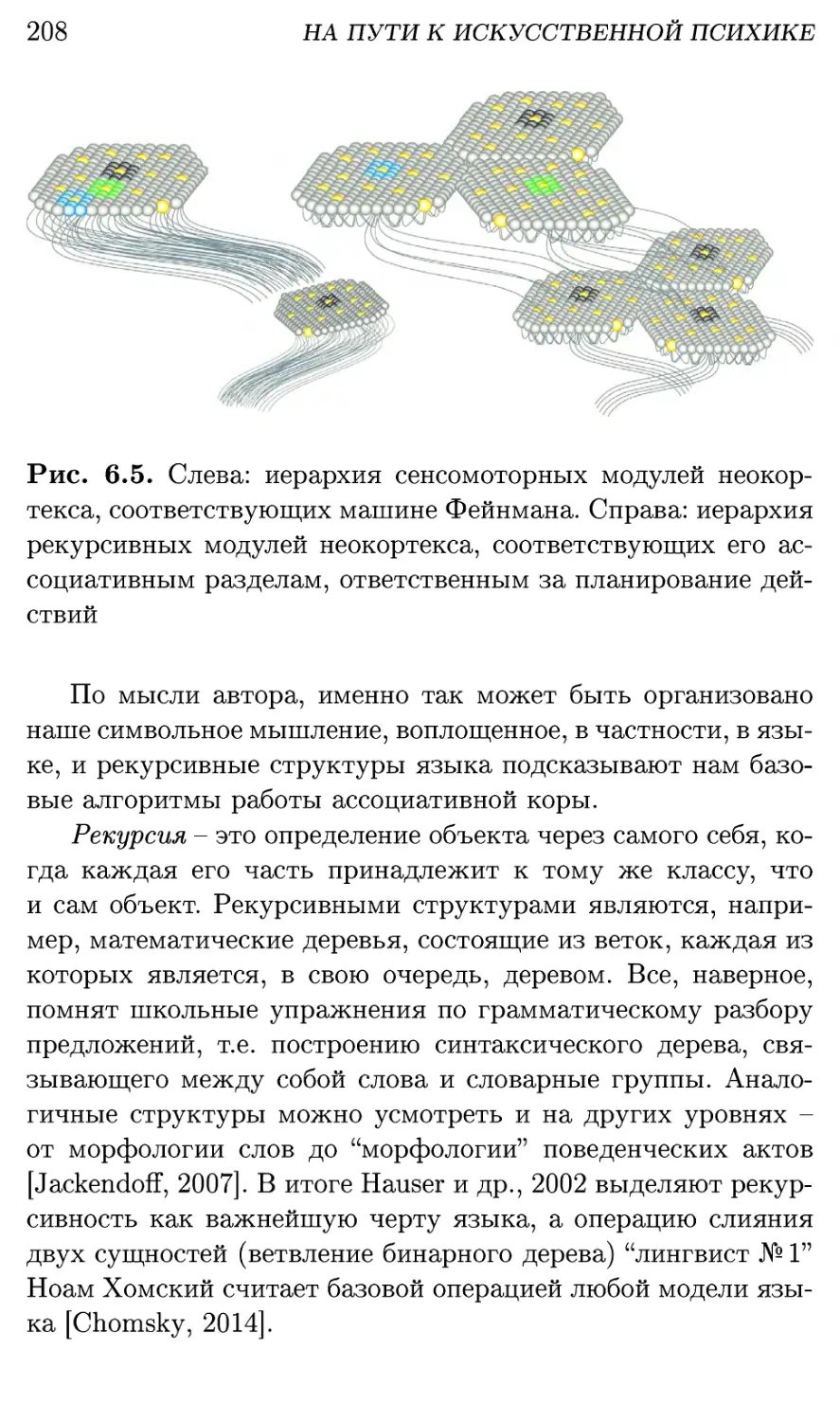

6.4. Гипотеза о рекурсивных модулях коры 206

6.5. Структурное обучение 210

6.5.1. Основная идея метода 210

6.5.2. Алгоритм структурного обучения 212

6.5.3. Предсказания с помощью модели 214

6.5.4. Обучение с подкреплением 215

6.5.5. Разреженное кодирование 216

6.6. Глубокое структурное обучение 219

6.6.1. Семантическое кодирование 220

6.6.2. Иерархия структур 222

6

6.6.3. Активное обучение 224

6.6.4. Сложность структурного обучения .... 226

6.6.5. Иерархия предсказаний 227

6.7. Обсуждение 228

Глава 7. Мозг и язык 233

7.1. Смогут ли машины говорить? 233

7.2. Родовые свойства языка 235

7.3. Глубокое структурное обучение языку 238

7.3.1. Морфология 238

7.3.2. Синтаксис и семантика 240

7.3.3. Разбор предложений 242

7.3.4. Значения фраз и предложений 243

7.3.5. Семантический поиск 246

7.3.6. Скорость обучения 249

7.4. Как мозг кодирует язык 249

7.4.1. Модель "органа языка" 249

7.4.2. Как язык представлен в мозге 253

7.5. Обсуждение 258

Глава 8. Направления развития 265

8.1. Действующая модель мозга 266

8.1.1. Как работает наш мозг? 266

8.1.2. Продление жизни мозга 268

8.1.3. Действующие модели мозга 269

8.1.4. Лечение и апгрейд мозга 271

8.2. Операционная система роботов 272

8.2.1. Как сделать роботы доступными? 272

8.2.2. Кто станет новой Microsoft? 273

8.2.3. Иерархическое модульное обучение .... 273

8.2.4. Зарплатные схемы для роботов 275

8.3. Экспертный интеллект 277

8.3.1. Как ускорить R&D? 277

8.3.2. Суперинтеллект суперкомпьютеров .... 277

8.3.3. Иерархическая модель языка 278

8.3.4. Супер-Google - консультант 280

ОГЛАВЛЕНИЕ 7

8.4. Обсуждение 281

Глава 9. Будущее машинного интеллекта 283

9.1. Развитие элементной базы 284

9.2. Интеллектуальные агенты 287

9.3. Роботы 289

9.4. Люди 291

9.5. Новая научная революция 295

Глава 10. Эволюция разума 299

10.1. Неравновесная термодинамика 301

10.2. Жизнь как форма разума 303

10.3. Мозг как контроллер поведения 304

10.4. Человеческий разум 306

10.5. Машинный интеллект 309

Глава 11. Несколько слов о смысле жизни 313

Список литературы 315

Глава 1

Пролог

Новыми путями иду я,

новая речь приходит ко

мне; устал я, подобно всем

созидающим, от старых

языков. Не хочет больше

мой дух бродить на

истоптанных подошвах.

Вы, смельчаки вокруг

меня! Вы, искатели,

испытатели и те из вас,

кто плавает под

коварными парусами по

неисследованным морям!

Вы, любители загадок!

Разгадайте же мне

загадку, которую я видел

... кто он, кто однажды

ещё должен придти?

Фридрих Ницше

«Так говорил Заратустра»

10

ПРОЛОГ

1.1. О чем и для кого эта книга

1.1.1. О чем эта книга

Эта книга о природе разума и разумного поведения. В

частности и в особенности - о человеческом и машинном интеллекте.

Мы будем использовать один и тот же язык теории

машинного обучения и для понимания принципов работы мозга,

и для проектирования искусственных интеллектуальных

систем, а в перспективе — сильного машинного интеллекта.

Автор видит свою цель в наведении мостов между

нейрофизиологами, изучающими мозг, и

инженерами-конструкторами нейроморфных когнитивных систем, использующих

принципы работы мозга.

1.1.2. Для кого эта книга

Эта книга — своего рода манифест, призыв к участию в

начинающейся новой научной революции. Она писалась для тех,

кто ориентирован на новые открытия в области

искусственного интеллекта. Для тех, кому интересна архитектура

человеческого мозга и построение сильного искусственного

интеллекта с оглядкой на интеллект естественный. Для

архитекторов и генеральных конструкторов искусственной психики

роботов — интеллектуальных операционных систем следующих

поколений.

Наука и бизнес сегодня делаются командами, а успех

командной работы во многом зависит от степени

взаимопонимания людей с очень разными бэкграундами. Новые разработки

в области искусственного интеллекта привлекают как

математиков и инженеров, так и нейрофизиологов, психологов и

лингвистов. Эта книга — скромная попытка автора

предоставить им своего рода Розеттский камень — текст, одинаково

понятный и тем, и другим. Чтобы дать возможность

биологам взглянуть на известные им факты глазами машинного

обучения, а специалистам по искусственному интеллекту —

взглянуть на свою область глазами биологов.

1.1. О чем и для кого эта книга

11

Поскольку задачи мозга во многом сводятся к обучению,

то его конструкция не может быть понята безотносительно

к этим задачам, т.е. без привлечения идей машинного

обучения. Последние помогают понять общие принципы работы

мозга, задающие рамку для огромного количества

эмпирических фактов, касающихся мозга и поведения. С другой

стороны, для создания когнитивных систем роботов важно

понимать архитектуру мозга и его функционирование на

системном уровне, без биологических деталей.

Розеттский камень, как известно, содержит один и тот же

текст на трех языках. Эта книга тоже адресуется не

только исследователям и разработчикам, но и предпринимателям,

инициаторам и организаторам новых проектов в венчурной

по своей природе индустрии машинного интеллекта. Им

будут интересны главы о перспективах развития искусственного

интеллекта и его месте в будущей цифровой экономике.

Кроме описанной выше целевой аудитории, книга может

быть полезна всем, кто интересуется природой разума, как

естественного, так и искусственного. Уровень изложения

примерно соответствует младшим курсам университетов, т.е.

материал в целом вполне доступен широкой публике,

особенно публицистическая начальная и научно-популярные

конечные главы. Более сложные для понимания главы,

требующие определенной математической подготовки и усилий,

снабжены соответствующими предупреждениями. Их при первом

чтении рекомендуется пропустить, чтобы не "сбивать

дыхания".

1.1.3. Почему это важно

В последнее десятилетие в области искусственного интеллекта

произошла революция глубокого обучения, которая коренным

образом изменила место машинного интеллекта на

технологической карте мира. Большое число практически важных

задач, не поддававшихся решению десятилетиями —

распознавание речи, машинное зрение, машинный перевод, — были

12

ПРОЛОГ

решены путем обучения т.н. глубоких искусственных

нейронных сетей (с миллиардами настроечных параметров).

Искусственный интеллект, основанный на машинном

обучении, за эти годы вышел из стен лабораторий в реальный

мир. В смартфонах поселились умные агенты, а автомобили

научились ездить без водителей. Быстрыми темпами

эволюционируют роботы. Резко увеличилось и продолжает расти

финансирование и число специалистов в области машинного

обучения, растет поток публикаций.

В разгар этой научной революции любой обзор ее

конкретных достижений успевает устареть еще в процессе

подготовки, до появления на свет. Именно поэтому в этой книге мы

хотим сосредоточиться не на текущем состоянии, а на

следующих этапах развития отрасли. На вопросах, которые будут

актуальны еще какое-то, возможно длительное, время, — на

нерешенных проблемах и возможных подходах к их решению.

Главной такой нерешенной задачей сегодня является

создание сильного искусственного интеллекта

(сверх)человеческого уровня, способного самостоятельно мыслить,

развиваться, общаться с людьми на естественном языке и, тем

самым, кардинально расширить возможности человечества.

На самом деле нам предстоит решить еще более сложную

задачу создания дружественного искусственного

интеллекта, симбиоза человеческого и сверхчеловеческого разума.

Сегодня мы понимаем машинное обучение в основном как

обучение машин нами. На повестке дня — создание

самообучающихся машин. Но вслед за этим непременно возникнет

проблема обучения нас машинами. Сможем ли мы понять

результаты машинного мышления, овладеть новыми знаниями,

полученными машинами? Чтобы понимать машинный

интеллект и доверять ему1.

1 На самом деле это уже происходит, например, в Го и шахматах,

где машинный уровень игры уже далеко превосходит человеческий. И

профессионалы сегодня используют машинный интеллект для

проникновения в тайны своей любимой игры, открытые этим сверхчеловеческим

игровым разумом (см. раздел 4.8.).

1.2. Структура книги

13

Решение этих задач, по мнению автора, невозможно без

более глубокого понимания принципов человеческого и

машинного интеллекта. Чтобы созданная нами искусственная

психика роботов была совместима с человеческой.

1.2. Структура книги

Автор не случайно определил жанр книги как очерки.

Отдельные ее главы основаны на лекциях, прочитанных автором

на протяжении ряда лет, и потому относительно независимы.

Это удобно, особенно с учетом предполагаемой разнородности

читательской аудитории.

Скажем, широкой публике будут интересны главы 2, 4

и 8-10, в которых современное состояние и перспективы

искусственного интеллекта изложены простым языком, так что

желающие смогут познакомиться с предметом за один или

несколько вечеров. Стесненные во времени предприниматели

могут вполне ограничиться 2, 8 и 9 главами. Тем, кому

интересно устройство и принципы работы мозга, будут полезны

главы 5 и 7. Наконец, разработчикам, не знакомым с

предметом и желающим максимально быстро войти в тему, чтобы

лучше понимать суть алгоритмов машинного обучения,

можно порекомендовать главы 2-4.

Но, в целом, изложение материала имеет свою

внутреннюю логику:

В главе 2 мы рассмотрим место машинного интеллекта в

современном мире и его особую роль замыкающей

технологии нового техноуклада. Мы покажем, насколько серьезны те

вызовы, на которые отвечает машинный интеллект, и каким

образом он сможет повысить эффективность мировой

экономики. Это должно помочь читателю лучше осознать

перспективы развития машинного интеллекта, мотивируя его на

более глубокое погружение в эту область.

Глава 3 представит основы машинного обучения и

определит его место в системе наук. Речь пойдет о математике обу-

14

ПРОЛОГ

чения — постановке основных задач и методов их решения.

Будут рассмотрены базовые типы обучения и

соответствующие алгоритмы.

Глава 4 посвящена революции глубокого обучения — ее

причинам, достижениям и практическим применениям, уже

внедренным и еще ждущим своего воплощения. Наша

задача — угадать вектор развития отрасли и технологические

барьеры, которые предстоит преодолеть в пределах ближайших

5-10 лет.

Глава 5 показывает, как принципы глубокого машинного

обучения помогают понимать и моделировать механизмы

работы мозга. В частности, объясняются способы обучения и

взаимодействия друг с другом основных подсистем мозга

млекопитающих и, конкретнее, приматов. Нас будут интересовать

основные принципы архитектуры мозга, такие как

модульность и иерархичность, позволившие нашим предкам

наращивать возможности мозга в ходе эволюции за счет роста числа

однотипных модулей. Эти же принципы можно использовать

и для создания масштабируемого машинного интеллекта.

В главе 6 приводится теория глубокого структурного

обучения с подкреплением, моделирующая символьное

мышление, дополняя, тем самым, возможности нейросетей по

работе с образами. Теория основана на выявленных в предыдущей

главе архитектурных принципах, и на ее основе можно

строить модели искусственной психики роботов,

самообучающейся операционной системы нового поколения.

В главе 7 рассмотрен частный случай этой теории —

обучение языку, а именно - языковым конструкциям разного

уровня — морфологическим, синтаксическим и семантическим.

Обсуждается их локализация в мозге и приводятся

экспериментальные результаты машинного обучения языку.

Глава 8 иллюстрирует возможные пути

коммерциализации полученных ранее результатов: обсуждается ряд

амбициозных проектов-ледоколов, преодолевающих важные

технологические барьеры и открывающих новые горизонты для биз-

1.3. Благодарности

15

неса. Ее цель — мобилизовать инициативные команды для

реализации такого рода проектов, что может быть особенно

интересно именно предпринимателям.

Глава 9 описывает, как может выглядеть будущее лет

через 10-15 в случае успеха рассмотренных проектов и какие

проблемы нас там ожидают. Будем надеяться, что их

решение будет найдено в ходе новой научной революции, связанной

с раскрытием общих принципов мышления.

Наконец, в заключительной 10-й главе мы расширим

горизонт предсказаний, представив картину развития разума на

Земле на протяжении 3,5 миллиардов лет. Чтобы показать,

что разум присущ природе и, раз возникнув, он неизбежно

ускоряет свое собственное развитие. Так что события,

описанные в предыдущей главе, в какой-то степени неизбежны.

1.3. Благодарности

В этой книге мы рассматриваем человеческое мышление как

общественный феномен. Это касается и содержания самой

книги: идеи, сформулированные автором, рождались, как

правило, совместно - в спорах и обсуждениях с коллегами.

Поэтому я искренне благодарен всем, кто прямо или косвенно

принимал участие в ее рождении. Чтобы не утомлять

читателя, упомяну лишь организации и сообщества, в которых

проходили обсуждения затронутых в книге вопросов.

Начиная с фондов «Династия» и «Траектория», сообществ НТИ и

Нейронет, включая недавно созданный при МФТИ Центр

науки и технологий искусственного интеллекта, и, last but not

least, клуб визионеров по искусственному интеллекту http:

//opentalks.ai/thinktank.

Автор искренне надеется, что эта книга привлечет

внимание талантливых и амбициозных молодых людей и будет

способствовать развитию индустрии машинного интеллекта в

России.

Глава 2

Машинный интеллект

в современном мире

По тысяче мостов и

тропинок должны

протискиваться они к

будущему, и пусть между

ними будет всё больше

войны и неравенства: так

заставляет меня говорить

моя великая любовь!

Даже то, чего вы не

делаете, ткёт ткань всего

человеческого будущего;

даже ваше ничто есть

паутина и паук, живущий

кровью будущего.

Фридрих Ницше

«Так говорил Заратустра»

18 МАШИННЫЙ ИНТЕЛЛЕКТ В СОВРЕМЕННОМ МИРЕ

2.1. Машинный интеллект: время пришло?

Перед погружением в новую тему всегда полезно задуматься:

а окупятся ли предстоящие усилия? В этой главе мы взглянем

на технологию искусственного интеллекта с высоты птичьего

полета, рассмотрим ее место в современной цифровой

экономике. Наша задача — понять: это действительно всерьез и

надолго? Или это очередная модная тема, на время

захлестнувшая ТВ-каналы и обложки глянцевых журналов, пока

аудитория ей в очередной раз не пресытится.

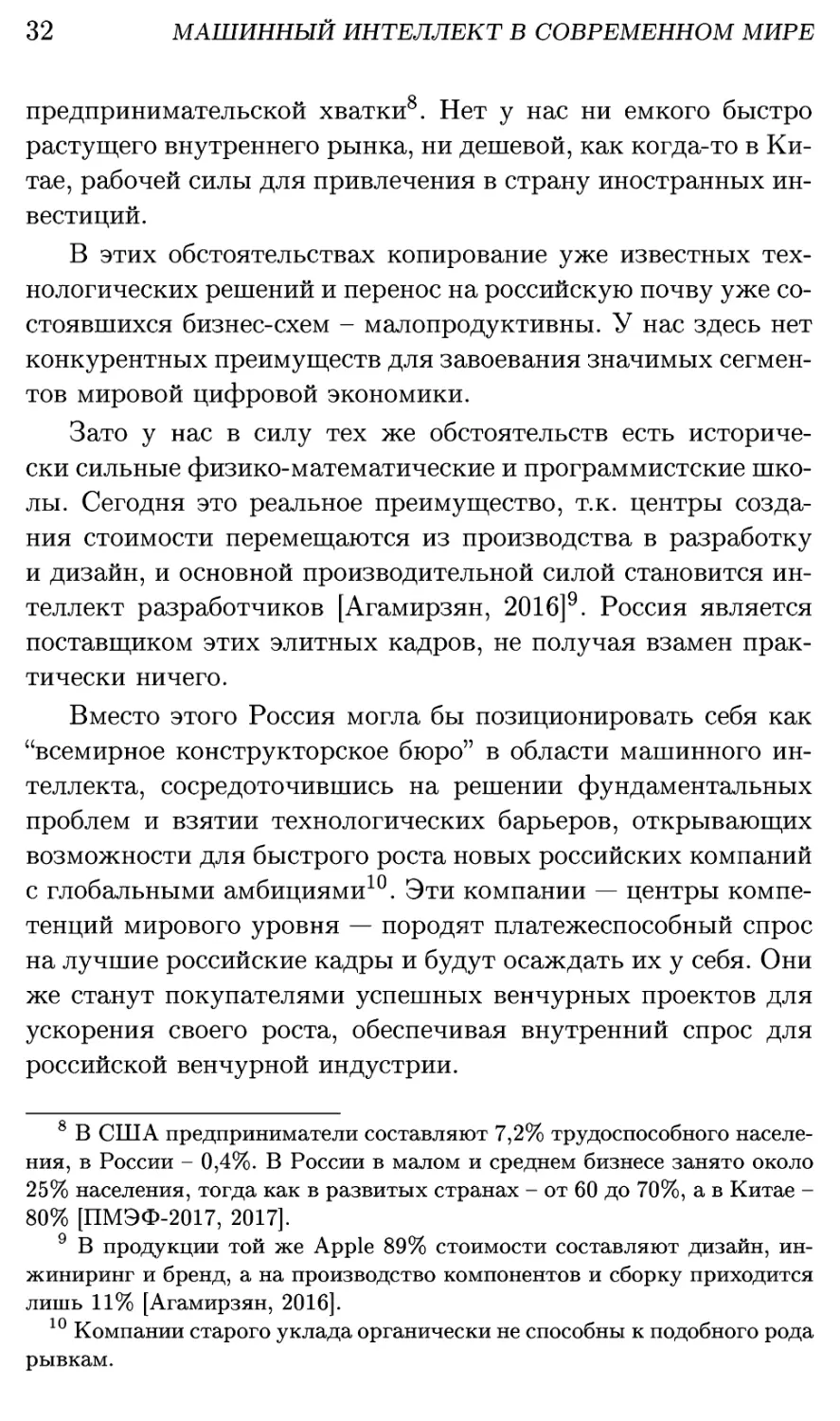

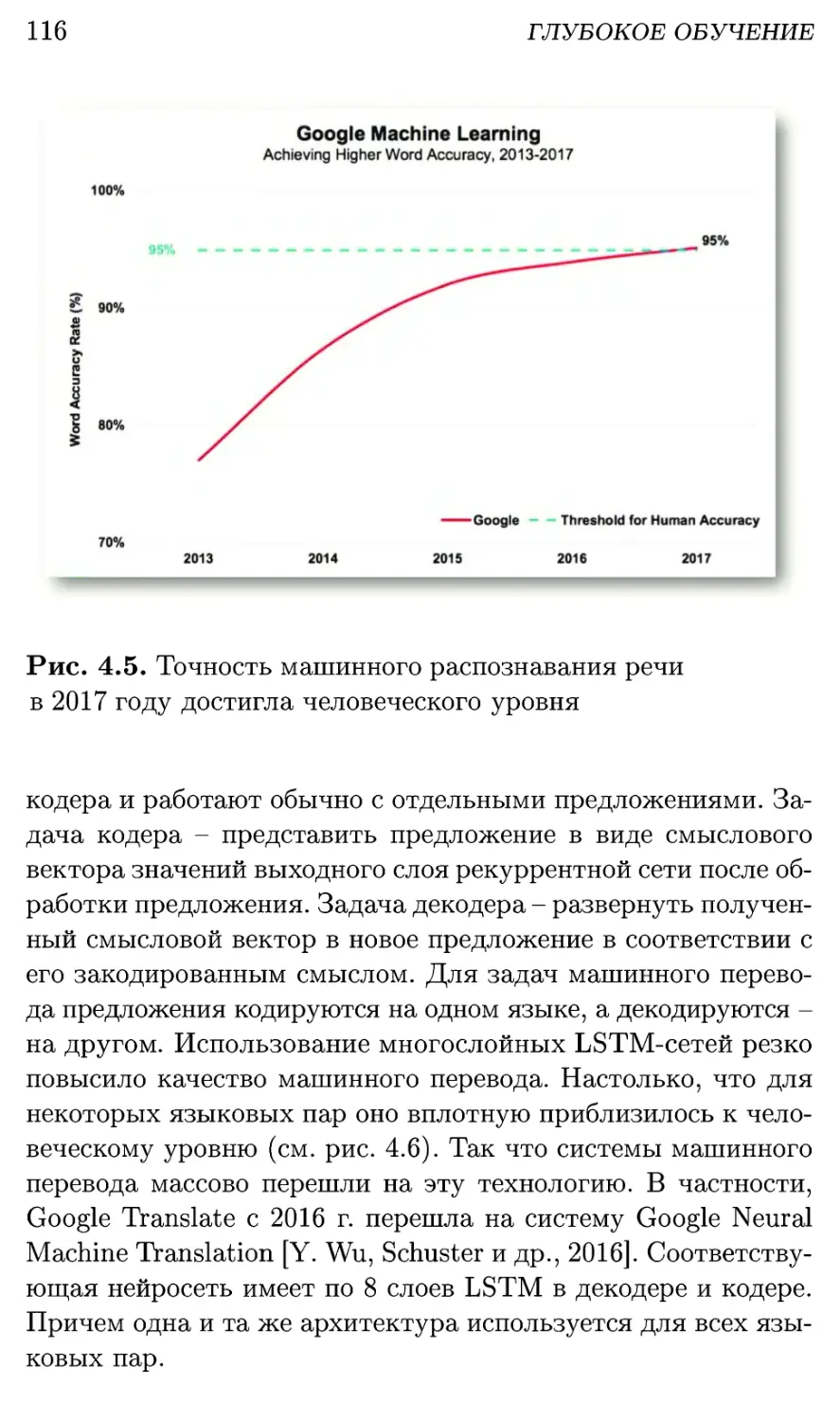

Рис. 2.1. Глубокие нейронные сети, "рабочая лошадка"

современного искусственного интеллекта, находятся сегодня на

пике ажиотажа и завышенных ожиданий. За этим неизбежно

следуют разочарования, и лишь постепенно, по мере

взросления технологий - выход на плато продуктивности. Однако, по

мнению Gartner, плато продуктивности для глубокого

обучения ожидается довольно скоро - в пределах ближайших 5 лет

[Panetta, 2018]

2.1. Машинный интеллект: время пришло?

19

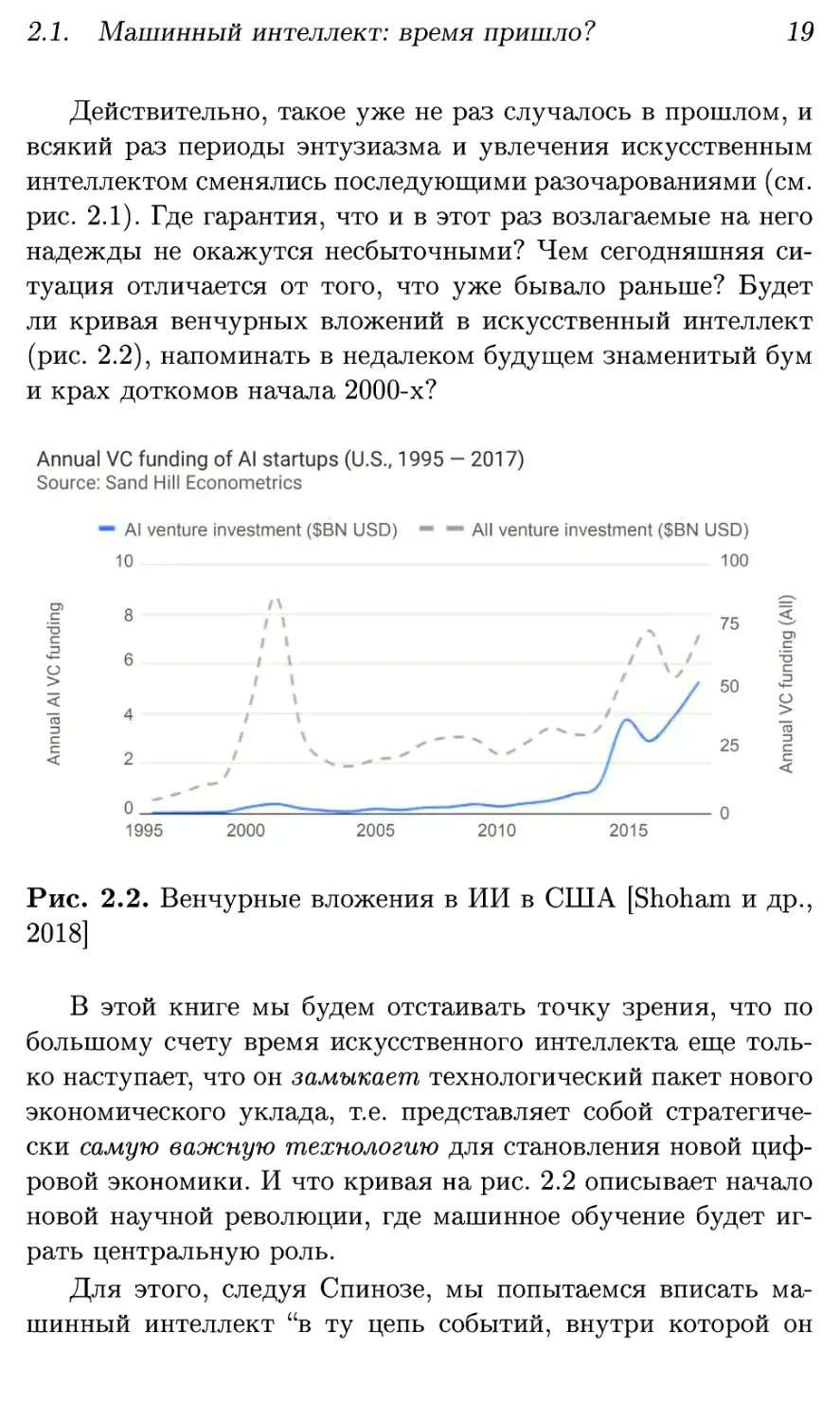

Действительно, такое уже не раз случалось в прошлом, и

всякий раз периоды энтузиазма и увлечения искусственным

интеллектом сменялись последующими разочарованиями (см.

рис. 2.1). Где гарантия, что и в этот раз возлагаемые на него

надежды не окажутся несбыточными? Чем сегодняшняя

ситуация отличается от того, что уже бывало раньше? Будет

ли кривая венчурных вложений в искусственный интеллект

(рис. 2.2), напоминать в недалеком будущем знаменитый бум

и крах доткомов начала 2000-х?

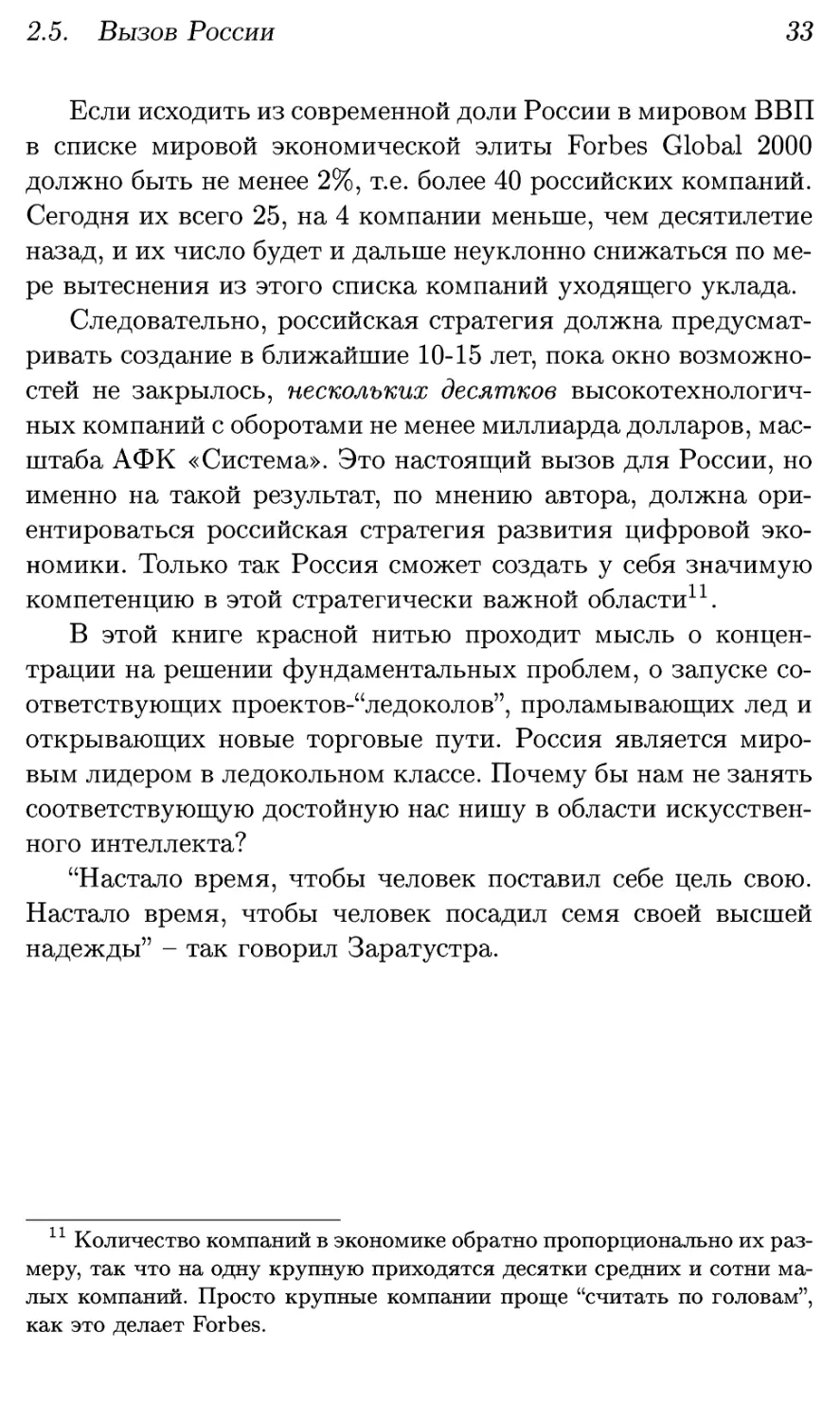

Рис. 2.2. Венчурные вложения в ИИ в США [Shoham и др.,

2018]

В этой книге мы будем отстаивать точку зрения, что по

большому счету время искусственного интеллекта еще

только наступает, что он замыкает технологический пакет нового

экономического уклада, т.е. представляет собой

стратегически самую важную технологию для становления новой

цифровой экономики. И что кривая на рис. 2.2 описывает начало

новой научной революции, где машинное обучение будет

играть центральную роль.

Для этого, следуя Спинозе, мы попытаемся вписать

машинный интеллект "в ту цепь событий, внутри которой он

20 МАШИННЫЙ ИНТЕЛЛЕКТ В СОВРЕМЕННОМ МИРЕ

возникает с необходимостью, а не случайно". То есть взглянем

на развитие цивилизации как на процесс, в который

искусственный интеллект органично вписывается именно сегодня,

разрешая некую актуальную, назревшую проблему.

2.2. Преодоление барьера сложности

Развитие человеческой цивилизации можно рассматривать как

процесс постоянного обучения, т.е. накопления знаний.

Действительно, что отличает современного человека от его

далеких предков, ранних homo sapiens? Физиологически -

ничего, единственное различие - в объеме накопленных

человечеством знаний. Под знаниями здесь понимаются не столько

тексты, сколько операционные знания "на кончиках пальцах"

представителей всех человеческих профессий. Они

передаются как формально, в виде научных статей, технических

регламентов, должностных инструкций и т.д., так и неформально,

от наставника к ученику.

Эти знания направляют поведение людей и приводят в

действие всю мировую экономику. Их суммарный объем

определяет сложность "экономического организма" и объем

производимых экономикой благ. Блага цивилизации можно

измерять не деньгами, а количеством доступных товаров и услуг

[Beinhocker, 2006]. Чем разнообразнее товарная

номенклатура, тем больше возможностей имеет человек для

удовлетворения своих потребностей, тем выше степень развития

экономики. Иными словами, экономическое благополучие

прямо пропорционально количеству накопленных человечеством

знаний.

Рост благосостояния означает, что объем этих знаний

растет быстрее, чем численность населения. Действительно,

расселение homo sapiens по Земле началось около 100 тысяч лет

назад с африканской популяции численностью порядка 105

2.2. Преодоление барьера сложности

21

человек . Сегодня нас уже 10 , т.е. численность населения

увеличилась на пять порядков. Однако номенклатура

изделий за то же время увеличилась на десять порядков - с несколь

ких вариантов каменных орудий до 1010 (разнообразие

маркировки современных штрих-кодов UPC).

То есть количество накопленных знаний растет примерно

пропорционально квадрату числа людей, в головах которых

эти знания "установлены"2. Очевидно, что накапливаться с

такой скоростью бесконечно знания не могут. Рано или

поздно начнут сказываться естественные ограничения

человеческого мозга, из-за которых максимальный суммарный объем

памяти человечества растет с ростом населения линейно, т.е.

гораздо медленнее.

Гипотеза автора состоит в том, что это "рано или поздно"

уже наступило. Человечество уже столкнулось с проблемой

преодоления барьера сложности экономики с ее растущей

номенклатурой изделий и глобальной системой разделения

труда.

Предельно огрубляя ситуацию, предположим, что все

люди специализируются каждый на каком-то одном "изделии".

В первобытном обществе при минимальном разделении труда,

все были заняты производством одних и тех же изделий, т.е.

человеческие знания многократно дублировались. Рост

экономики происходил за счет все более рационального

использования совокупной памяти человечества - углубления

разделения труда и появления все большего числа профессий.

Современный мир, по-видимому, приближается к предельной

степени разделения труда, когда набор знаний каждого

специалиста становится уникальным. В этом пределе разнообразие

изделий приближается к своему теоретическому максимуму -

количеству людей (см. рис. 2.3).

1 В этой книге мы будем часто использовать оценки с точностью до

порядка, т.е. 105 надо понимать, как 0,3 • 105 -г- 3 • 105.

2 Мировой ВВП также пропорционален квадрату численности

населения [Коротаев и др., 2018], т.е. действительно растет пропорционально

объему знаний.

22 МАШИННЫЙ ИНТЕЛЛЕКТ В СОВРЕМЕННОМ МИРЕ

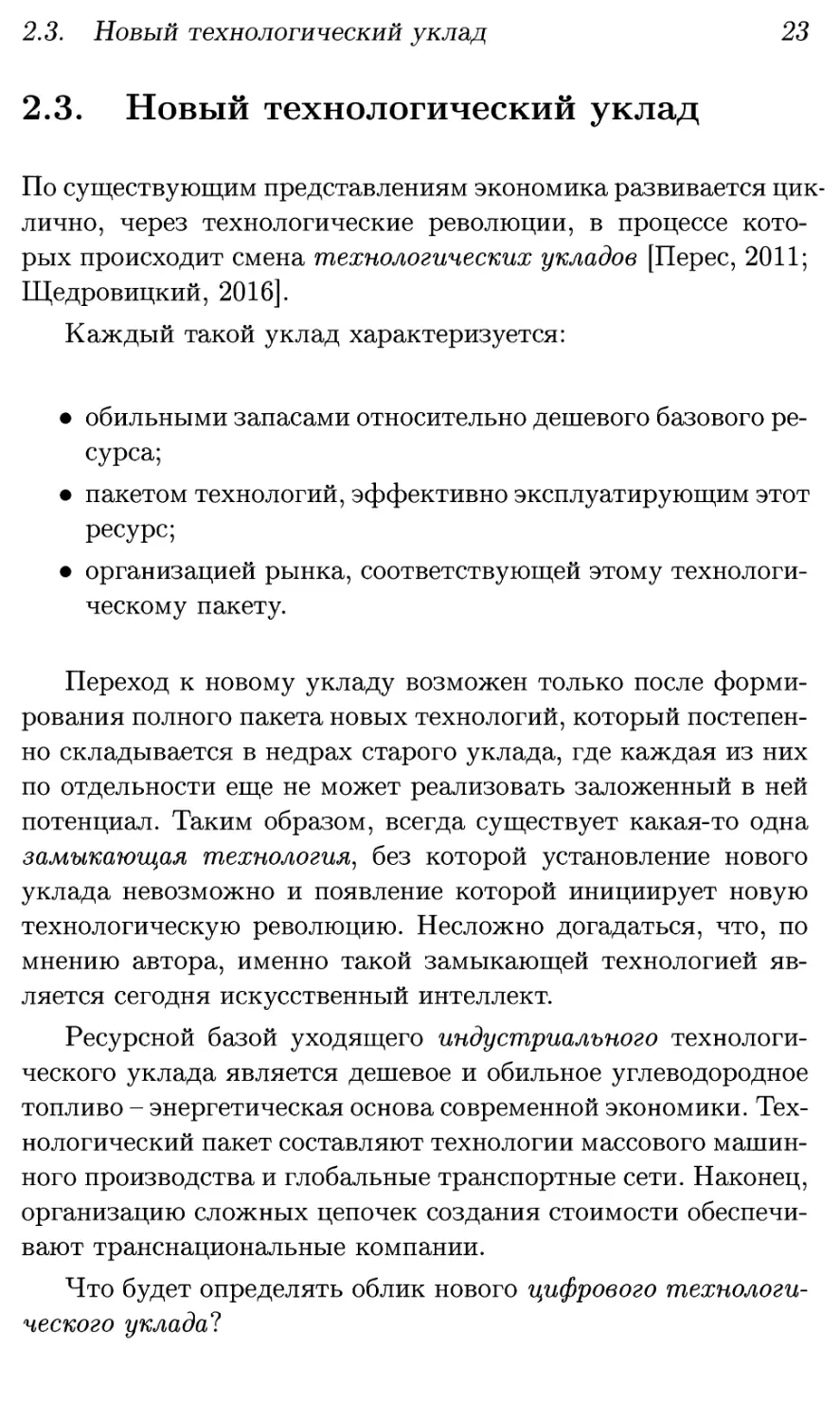

Рис. 2.3. Приближение мировой экономики к пределу

сложности, связанному с ограничениями человеческого мозга.

Здесь сложность мировой экономики С измеряется

количеством уникальных изделий, а N - численность человеческой

популяции

Хорошим индикатором приближения человечества к

этому пределу служит изменение закона роста численности

населения. На протяжении всей известной истории вплоть до

последней трети XX в. население Земли росло

приблизительно по гиперболе: пропорционально (to — £)-1 с точкой

сингулярности to « 2026 г. [Kremer, 1993; Von Foerster и др., 1960;

Капица, 1999]. Затем гиперболический рост начал

замедляться, и примерно с 2000 г. относительный темп роста населения

постоянно снижается. Можно трактовать этот факт как

свидетельство того, что текущий технологический уклад

исчерпал свой потенциал и больше не в состоянии поддерживать

прежние темпы роста.

Преодоление барьера сложности возможно только в

рамках нового цифрового технологического уклада.

2.3. Новый технологический уклад

23

2.3. Новый технологический уклад

По существующим представлениям экономика развивается

циклично, через технологические революции, в процессе

которых происходит смена технологических укладов [Перес, 2011;

Щедровицкий, 2016].

Каждый такой уклад характеризуется:

• обильными запасами относительно дешевого базового

ресурса;

• пакетом технологий, эффективно эксплуатирующим этот

ресурс;

• организацией рынка, соответствующей этому

технологическому пакету.

Переход к новому укладу возможен только после

формирования полного пакета новых технологий, который

постепенно складывается в недрах старого уклада, где каждая из них

по отдельности еще не может реализовать заложенный в ней

потенциал. Таким образом, всегда существует какая-то одна

замыкающая технология, без которой установление нового

уклада невозможно и появление которой инициирует новую

технологическую революцию. Несложно догадаться, что, по

мнению автора, именно такой замыкающей технологией

является сегодня искусственный интеллект.

Ресурсной базой уходящего индустриального

технологического уклада является дешевое и обильное углеводородное

топливо - энергетическая основа современной экономики.

Технологический пакет составляют технологии массового

машинного производства и глобальные транспортные сети. Наконец,

организацию сложных цепочек создания стоимости

обеспечивают транснациональные компании.

Что будет определять облик нового цифрового

технологического уклада?

24 МАШИННЫЙ ИНТЕЛЛЕКТ В СОВРЕМЕННОМ МИРЕ

2.3.1. Новый обильный и дешевый ресурс

Основным ограничивающим фактором индустриального

уклада, как мы выяснили, является не истощение энергетических

ресурсов, а ограниченные возможности человеческого мозга

по управлению все более сложной глобальной экономикой. "В

каждом продукте, которым мы пользуемся в начале XXI в.,

доля прямых и косвенных управленческих затрат составляет

от 50 до 80%" [Ковалевич и Щедровицкий, 2015].

Ответом на этот вызов стало появление и быстрое

развитие компьютерных технологий. Компьютеры позволили

вынести часть алгоритмов из головы человека в среду, где они

могут исполняться в миллионы раз быстрее. Соответственно,

все, что удается формализовать, переносится из головы

человека в эту новую искусственную цифровую среду.

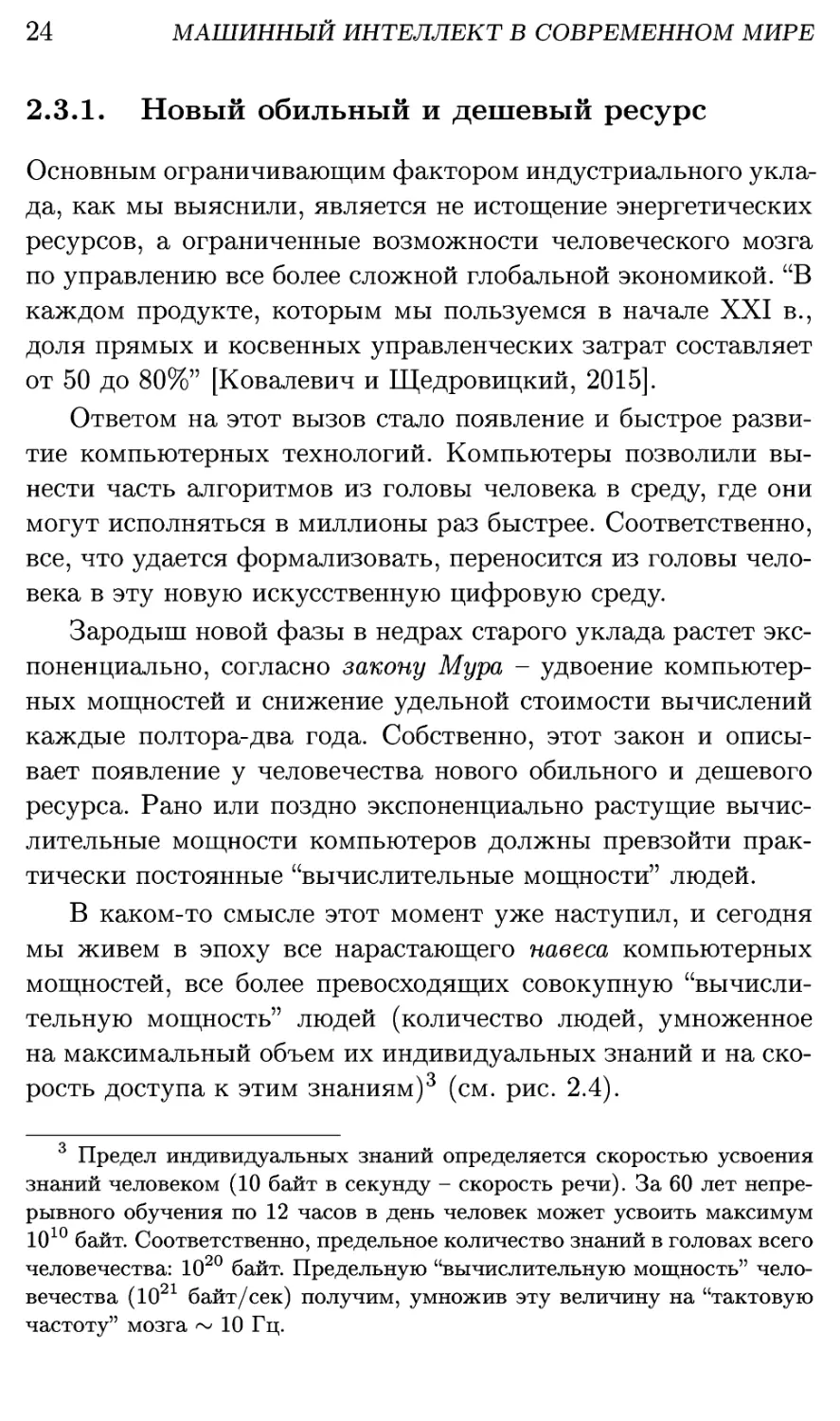

Зародыш новой фазы в недрах старого уклада растет

экспоненциально, согласно закону Мура - удвоение

компьютерных мощностей и снижение удельной стоимости вычислений

каждые полтора-два года. Собственно, этот закон и

описывает появление у человечества нового обильного и дешевого

ресурса. Рано или поздно экспоненциально растущие

вычислительные мощности компьютеров должны превзойти

практически постоянные "вычислительные мощности" людей.

В каком-то смысле этот момент уже наступил, и сегодня

мы живем в эпоху все нарастающего навеса компьютерных

мощностей, все более превосходящих совокупную

"вычислительную мощность" людей (количество людей, умноженное

на максимальный объем их индивидуальных знаний и на

скорость доступа к этим знаниям)3 (см. рис. 2.4).

3 Предел индивидуальных знаний определяется скоростью усвоения

знаний человеком (10 байт в секунду - скорость речи). За 60 лет

непрерывного обучения по 12 часов в день человек может усвоить максимум

1010 байт. Соответственно, предельное количество знаний в головах всего

человечества: 1020 байт. Предельную "вычислительную мощность"

человечества (1021 байт/сек) получим, умножив эту величину на "тактовую

частоту" мозга ~ 10 Гц.

2.3. Новый технологический уклад

25

Рис. 2.4. Рост совокупных компьютерных мощностей,

согласно Hilbert и Lopez, 2011. Они сосредоточены не в процессорах

общего назначения (CPU, нижняя ветка), а в графических

ускорителях (GPU, верхняя ветка), которые в основном и

используются для обучения искусственных нейросетей

Таким образом, компьютерные мощности представляют

собой новый дешевый и обильный ресурс для становления

нового цифрового технологического уклада. Более того, в отличие

от остальных ресурсов, он постоянно и очень быстро растет

и дешевеет, т.е. является сегодня основным потенциальным

источником экономического роста4.

Однако пока что этот заложенный в компьютерах

потенциал еще практически не задействован. Большую часть

времени они попросту простаивают. Согласно недавнему докладу

4 Конечно, компьютерные мощности - это не природный, а

технологический ресурс. Но технологические пакеты складываются из стеков

различных технологий, нижние этажи которых служат ресурсом для

верхних. Мы остановились на вполне зрелой массовой технологии

производства чипов, т.к. в противном случае пришлось бы считать основным

ресурсом цифровой экономики кремний или даже песок.

26 МАШИННЫЙ ИНТЕЛЛЕКТ В СОВРЕМЕННОМ МИРЕ

McKinsey, развитие цифровых технологий в США последние

30 лет сопровождалось снижением темпов роста

производительности труда [Manyika и др., 2017].

По мнению автора, только машинный интеллект способен

раскрыть истинный экономический потенциал компьютеров,

позволяя решать проблемы лучше, быстрее и дешевле

человека.

2.3.2. Новый технологический пакет

Почему именно машинный интеллект? Что принципиально

нового добавит он к имеющимся компьютерным технологиям?

И почему этих технологий недостаточно для эффективной

эксплуатации растущих и дешевеющих компьютерных

мощностей?

Ответ лежит на поверхности. Просто совокупный объем

всех когда-либо созданных компьютерных алгоритмов

ничтожно мал по сравнению с объемом всех человеческих знаний.

Компьютеры, выражаясь бытовым языком, "быстрые, но

глупые". Соответственно, принятие основной массы решений по-

прежнему остается за людьми, а компьютеры играют

вспомогательную роль, осуществляя лишь те операции, которые

удалось формализовать и автоматизировать. В результате,

несмотря на все инвестиции в информационные технологии,

их влияние на экономику по-прежнему весьма ограничено.

Процесс формализации человеческих знаний идет крайне

медленно, т.к. алгоритмы создаются небольшой прослойкой

людей, программистами (их сегодня в мире порядка 10т).

Объем знаний в компьютерных программах ограничен

совокупными знаниями программистов, которые на три порядка

меньше общего объема человеческих знаний.

Если алгоритмы и дальше будут создаваться людьми, этот

процесс может затянуться навеки, с учетом скорости

обновления знаний. Единственный выход - избавиться от узкого

горла "ручного" программирования и перепоручить создание

программ компьютерам. Этот процесс автоматического по-

2.3. Новый технологический уклад

27

рождения алгоритмов как раз и обеспечивается машинным

обучением.

Таким образом, только машинное обучение,

подкрепленное достигнутым уровнем компьютерных мощностей,

способно в сжатые сроки резко повысить машинный интеллект до

человеческого уровня и загрузить эти мощности теми

задачами, которые сегодня доступны только людям.

Именно это мы и наблюдаем в последние несколько лет,

после того, как основной парадигмой искусственного

интеллекта стало т.н. глубокое обучение [LeCun, Bengio и др., 2015].

Именно с этим подходом связаны недавние успехи в задачах

компьютерного зрения, распознавания речи, машинного

перевода и т.д., где узкоспециализированный машинный

интеллект достигает уровня человека, т.е. может его частично

заменять.

Иными словами, именно искусственный интеллект

является замыкающей технологией нового технологического пакета,

необходимой и достаточной для начала новой промышленной

революции.

2.3.3. Новая организация рынка

В каждом укладе можно выделить базовые "клеточки" его

"экономического организма" [Щедровицкий, 2016]. Первая

промышленная революция породила фабрики, вторая -

транснациональные корпорации. Каким будет основной способ

организации рынка в новом цифровом укладе? Как в него

впишутся технологии искусственного интеллекта?

Основой индустриального уклада является массовое

производство и распределение товаров. Производители

наполняют рынок товарами, ориентируясь на массовый спрос. Всякий

нестандартный спрос остается неудовлетворенным.

В цифровом мире рынки настроены на индивидуальные

потребности. Возможность удовлетворить любой спрос

кратно расширяет объем рынка за счет эффекта длинного хвоста

[Андерсон, 2012]. Это касается также и рынка труда: как лю-

28 МАШИННЫЙ ИНТЕЛЛЕКТ В СОВРЕМЕННОМ МИРЕ

бой товар находит своего покупателя, так и любые

способности, знания и навыки находят свое применение в составе

временных проектных команд с уникальными комбинациями

уникальных компетенций. С передачей части работ

интеллектуальным агентам со сверхчеловеческими способностями

производительность труда может вырасти на порядки.

Тонкий баланс между спросом и предложением смогут

обеспечить цифровые платформы, оперирующие цифровыми

двойниками услуг, товаров и людей. Собственно, это мы сегодня

и наблюдаем: компании новой экономики предоставляют

исключительно персонализированные услуги: Google и Facebook

осуществляют индивидуальную доставку информации и

рекламы, Amazon и Netflix помогают подбирать товары и

развлечения по своему вкусу, угадывая потребности

пользователей по их цифровым следам.

Новые компании-платформы сегодня активно теснят

транснациональные компании прошлого уклада и растут темпами,

кратно превышающими рост мировой экономики (см. рис. 2.5,

2.6).

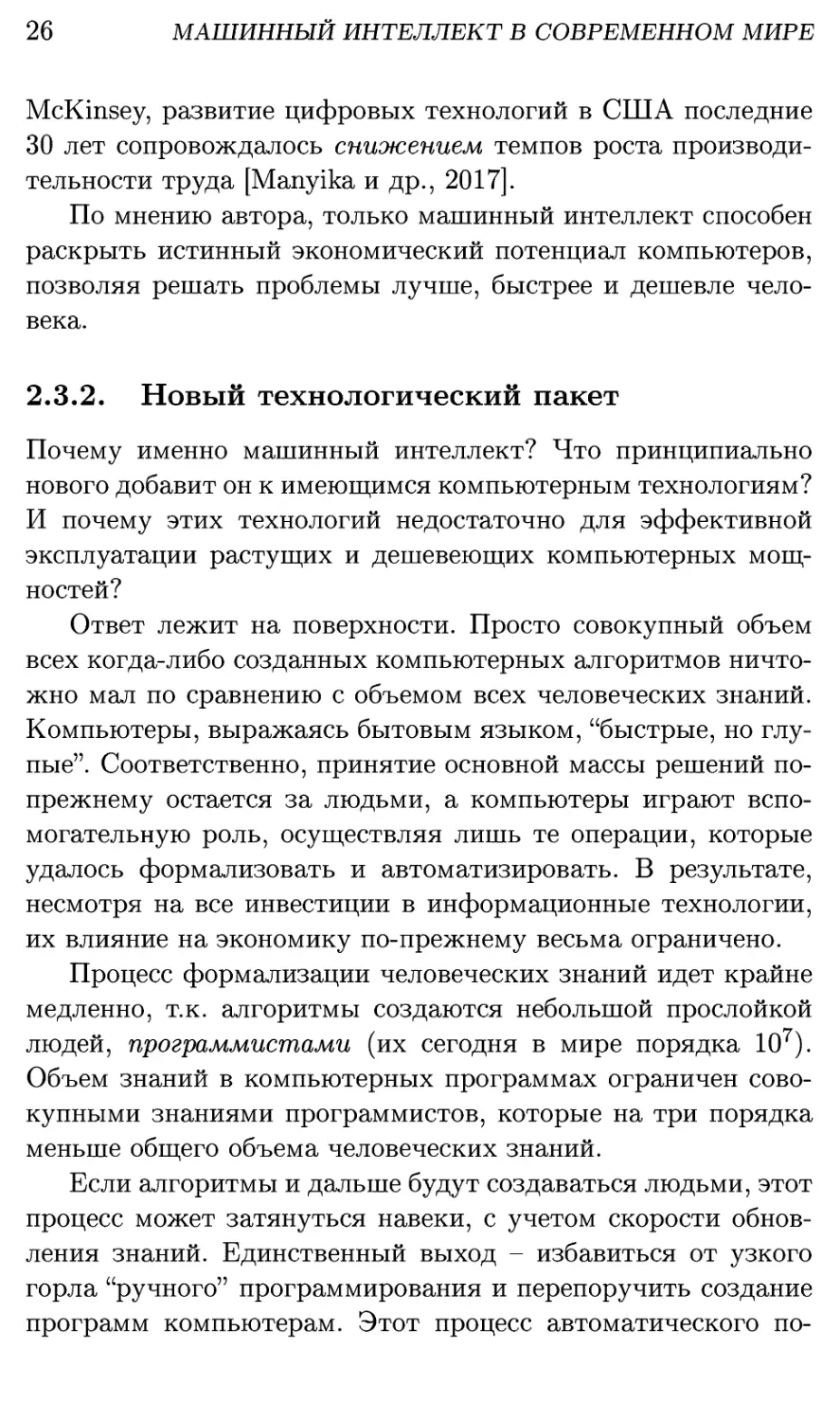

Рис. 2.5. Крупнейшими мировыми компаниями становятся

лидеры нового цифрового уклада [Desjardins, 2018]

2.4. Гонка за, искусственным интеллектом

29

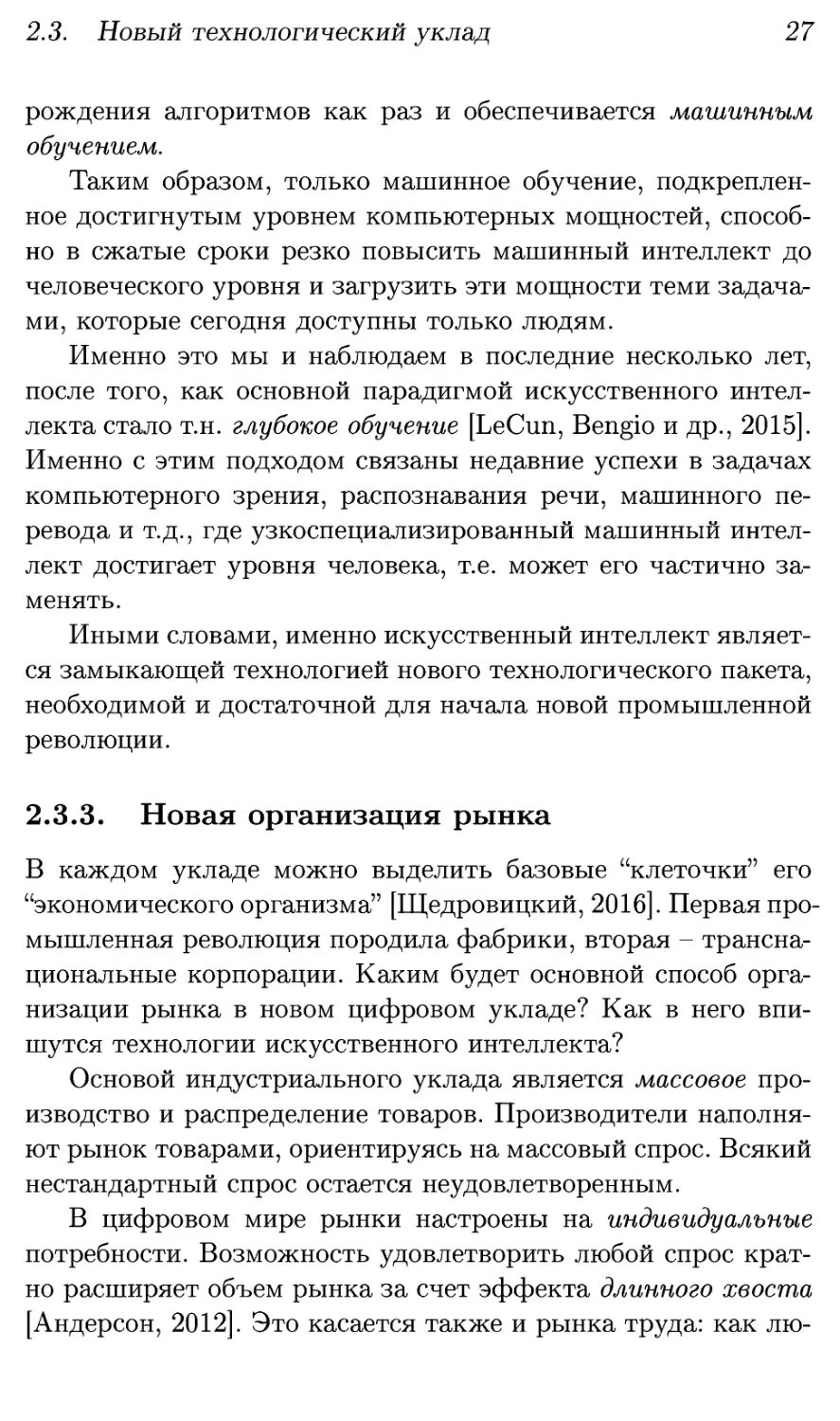

Рис. 2.6. Лидеры нового уклада растут опережающими

темпами. Среднегодовые темпы их роста (20-60%) на порядок

превышают темпы роста мировой экономики (2,5-3%)

Это объясняется эффектом положительной обратной

связи, характерным для новой экономики, основанной на

машинном обучении: больше клиентов - больше данных - лучше

качество сервиса - еще больше клиентов. Ведь результаты

машинного обучения пропорциональны объему данных.

Поэтому компании новой экономики, успевшие первыми захватить

свой сегмент рынка, быстро уходят в отрыв.

2.4. Гонка за искусственным интеллектом

Понимание исключительной роли лидерства в экономике

нового уклада породило новую технологическую гонку - за

искусственным интеллектом. В последние пару лет свои

национальные стратегии в области искусственного интеллекта

появились сразу у двух десятков стран [Карелов, 2018].

Едва начавшись, новая гонка уже не уступает ядерной и

ракетной гонкам XX в. по масштабу инвестиций, которые при

этом продолжают расти двузначными темпами5. Лидируют в

5 Эти инвестиции обещают окупиться сторицей. Согласно Bughin и

др., 2018 к 2030 г. ИИ способен прибавить примерно $13 трлн к общим

объемам выпуска и 1,2% к годовым темпам роста мирового ВВП.

30 МАШИННЫЙ ИНТЕЛЛЕКТ В СОВРЕМЕННОМ МИРЕ

ней с большим отрывом ее инициаторы - США и Китай (см.

рис. 2.7), однако цифровую экономику активно осваивают и

игроки меньшего масштаба, например Израиль6.

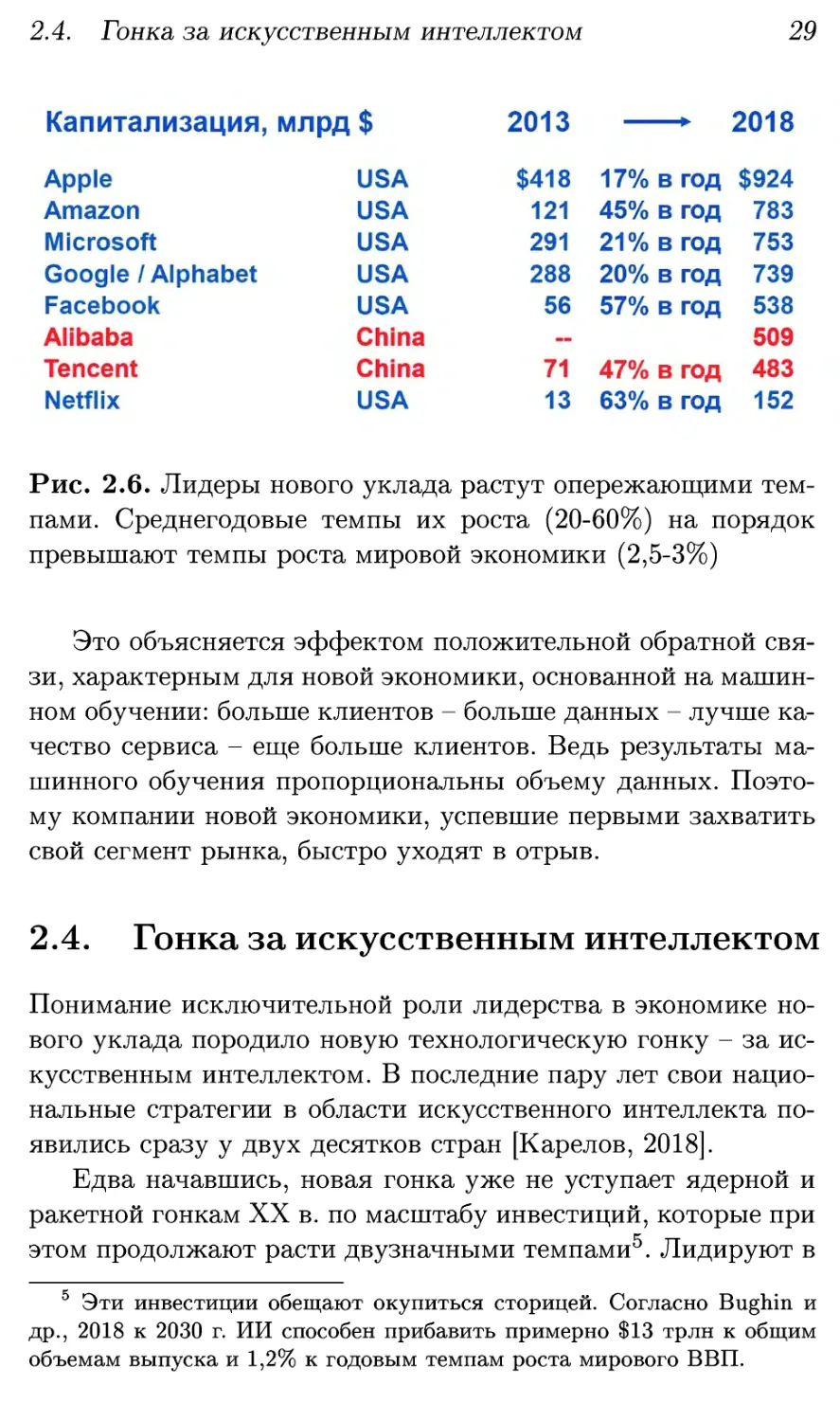

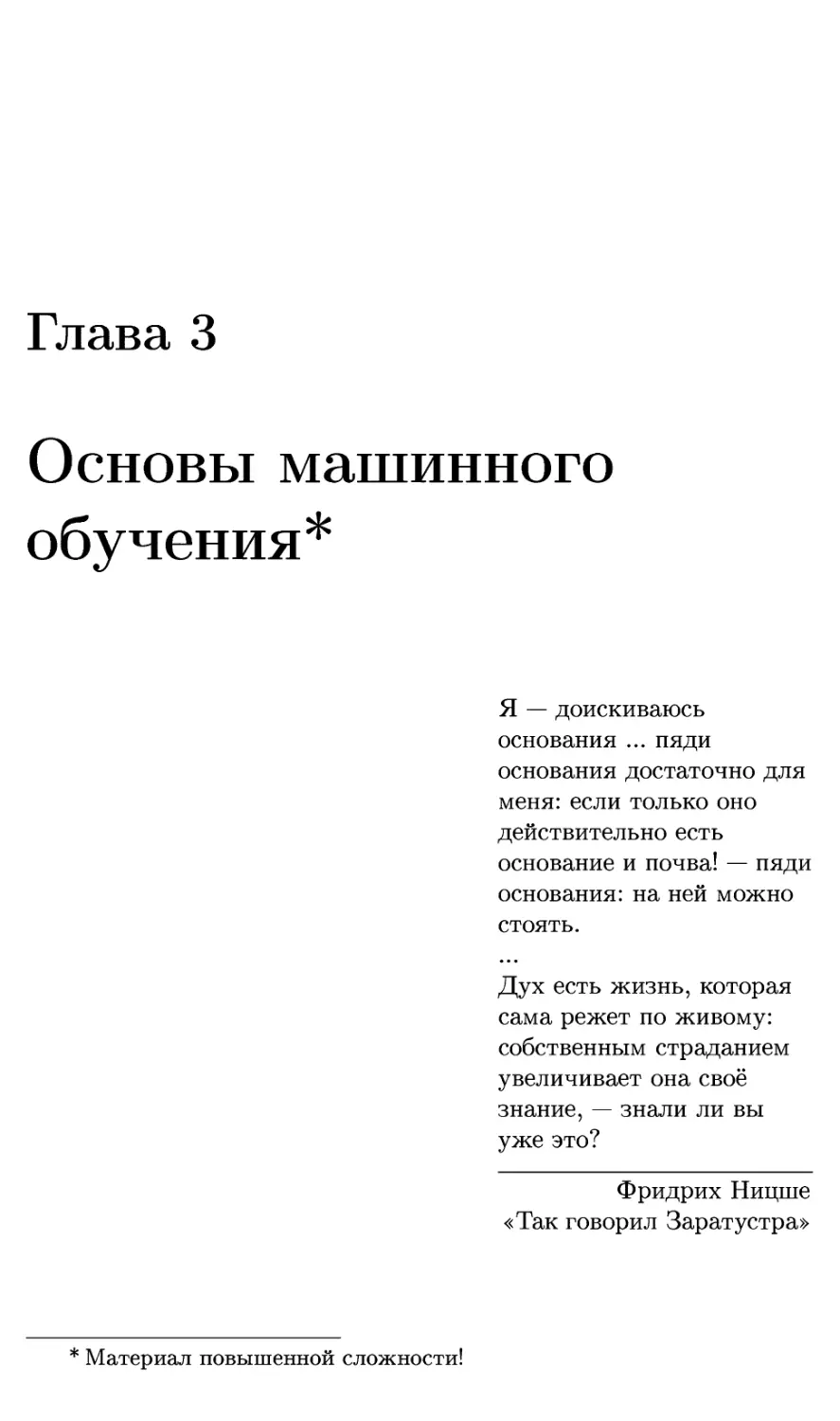

Рис. 2.7. Вложения в главные технологические гонки -

ядерную, ракетную и за искусственный интеллект. Данные по

Манхэттенскому проекту и проекту Аполлон взяты из Вики-

педии и пересчитаны в доллары 2016 г., вложения в

искусственный интеллект в 2016 г. - оценка Bughin и др., 2017

Участники гонки спешат включиться в глобальные

цепочки создания стоимости набирающей силу новой экономики, с

гораздо более высокой производительностью труда7.

Оставшиеся в стороне страны будут все больше отставать

от лидеров по уровню, качеству и продолжительности жизни

с риском отстать окончательно и превратиться в failed states.

Их суверенитет будет носить в значительной степени иллю-

6 В 2017 г. в израильские стартапы было вложено $2 млрд, на 70%

больше, чем в 2016 [Press, 2018].

7 К примеру, выручка Apple в расчете на одного сотрудника - около

$2,2 млн, в 7 раз выше, чем у Роснефти и в 70 раз выше, чем у

Ростелекома [Завадовская и Карпов, 2017].

2.5. Вызов России

31

зорный характер, т.к. все основные экономические решения

будут приниматься без их участия и без учета их

интересов. Вспомним незавидную участь Китая и Индии, которые

не вписались в первую промышленную революцию. А ведь до

нее они были технологическими лидерами и в совокупности

производили более 2/3 мирового ВВП!

С этих позиций главная угроза современной России -

оказаться одной из таких стран, дополнить экспорт сырой нефти

экспортом сырых данных, оставив все их высокие переделы и

всю прибавочную стоимость более развитым экономикам.

2.5. Вызов России

Сегодня для России открывается редкое окно возможностей -

поучаствовать в становлении новой экономики более-менее на

равных, застолбить за собой какие-то секторы быстро

растущих новых рынков, пока лидеры гонки не ушли в отрыв.

Конечно, у развитых стран, главным образом у США,

имеется существенный задел. Но это отнюдь не предопределяет

победу прежних лидеров в новой гонке. Так, Microsoft и Intel

не удалось утвердить свое лидерство на новом для них

рынке мобильных устройств, a Google, как ни старался, так и не

смог составить конкуренцию Facebook в социальных сетях.

Вышедшая недавно замечательная книга [Lee, 2018]

обосновывает высокие шансы Китая догнать и перегнать США в

этом соревновании. Стратегия Китая опирается на его

естественные конкурентные преимущества - лидерство в

мобильных платежах и электронной торговле, обилие порождаемых

ими данных, высококонкурентную среду малого и среднего

бизнеса.

Стратегия России тоже должна опираться на ее

конкурентные преимущества. В силу исторических обстоятельств

у нынешних россиян нет присущей китайцам и американцам

32 МАШИННЫЙ ИНТЕЛЛЕКТ В СОВРЕМЕННОМ МИРЕ

предпринимательской хватки8. Нет у нас ни емкого быстро

растущего внутреннего рынка, ни дешевой, как когда-то в

Китае, рабочей силы для привлечения в страну иностранных

инвестиций.

В этих обстоятельствах копирование уже известных

технологических решений и перенос на российскую почву уже

состоявшихся бизнес-схем - малопродуктивны. У нас здесь нет

конкурентных преимуществ для завоевания значимых

сегментов мировой цифровой экономики.

Зато у нас в силу тех же обстоятельств есть

исторически сильные физико-математические и программистские

школы. Сегодня это реальное преимущество, т.к. центры

создания стоимости перемещаются из производства в разработку

и дизайн, и основной производительной силой становится

интеллект разработчиков [Агамирзян, 2016]9. Россия является

поставщиком этих элитных кадров, не получая взамен

практически ничего.

Вместо этого Россия могла бы позиционировать себя как

"всемирное конструкторское бюро" в области машинного

интеллекта, сосредоточившись на решении фундаментальных

проблем и взятии технологических барьеров, открывающих

возможности для быстрого роста новых российских компаний

с глобальными амбициями10. Эти компании — центры

компетенций мирового уровня — породят платежеспособный спрос

на лучшие российские кадры и будут осаждать их у себя. Они

же станут покупателями успешных венчурных проектов для

ускорения своего роста, обеспечивая внутренний спрос для

российской венчурной индустрии.

В США предприниматели составляют 7,2% трудоспособного

населения, в России - 0,4%. В России в малом и среднем бизнесе занято около

25% населения, тогда как в развитых странах - от 60 до 70%, а в Китае -

80% [ПМЭФ-2017, 2017].

В продукции той же Apple 89% стоимости составляют дизайн,

инжиниринг и бренд, а на производство компонентов и сборку приходится

лишь 11% [Агамирзян, 2016].

1 Компании старого уклада органически не способны к подобного рода

рывкам.

2.5. Вызов России

33

Если исходить из современной доли России в мировом ВВП

в списке мировой экономической элиты Forbes Global 2000

должно быть не менее 2%, т.е. более 40 российских компаний.

Сегодня их всего 25, на 4 компании меньше, чем десятилетие

назад, и их число будет и дальше неуклонно снижаться по

мере вытеснения из этого списка компаний уходящего уклада.

Следовательно, российская стратегия должна

предусматривать создание в ближайшие 10-15 лет, пока окно

возможностей не закрылось, нескольких десятков

высокотехнологичных компаний с оборотами не менее миллиарда долларов,

масштаба АФК «Система». Это настоящий вызов для России, но

именно на такой результат, по мнению автора, должна

ориентироваться российская стратегия развития цифровой

экономики. Только так Россия сможет создать у себя значимую

компетенцию в этой стратегически важной области11.

В этой книге красной нитью проходит мысль о

концентрации на решении фундаментальных проблем, о запуске

соответствующих проектов-"ледоколов", проламывающих лед и

открывающих новые торговые пути. Россия является

мировым лидером в ледокольном классе. Почему бы нам не занять

соответствующую достойную нас нишу в области

искусственного интеллекта?

"Настало время, чтобы человек поставил себе цель свою.

Настало время, чтобы человек посадил семя своей высшей

надежды" - так говорил Заратустра.

Количество компаний в экономике обратно пропорционально их

размеру, так что на одну крупную приходятся десятки средних и сотни

малых компаний. Просто крупные компании проще "считать по головам",

как это делает Forbes.

Глава 3

Основы машинного

обучения*

Я — доискиваюсь

основания ... пяди

основания достаточно для

меня: если только оно

действительно есть

основание и почва! — пяди

основания: на ней можно

стоять.

Дух есть жизнь, которая

сама режет по живому:

собственным страданием

увеличивает она своё

знание, — знали ли вы

уже это?

Фридрих Ницше

«Так говорил Заратустра»

* Материал повышенной сложности!

36

ОСНОВЫ МАШИННОГО ОБУЧЕНИЯ

3.1. Основные понятия

3.1.1. Машинное обучение как наука

Машинное обучение — это науках о системах, способных к

обучению, и об интеллекте, как результате такого обучения,

это наука о той части природы, которая научилась

учиться. Она естественным образом дополняет физические

науки, которые ограничиваются системами, не способными к

обучению, и идейно близка биологическим наукам, поскольку

жизнь — это исторически первая часть природы,

научившаяся учиться.

Эволюция биосферы есть не что иное, как постоянное

накопление знаний о мире в генетическом коде биоты. Алгоритм

такого обучения (наследственность - изменчивость - отбор)

был открыт Дарвиным и позднее доработан с учетом

данных генетики. Подсмотренные у жизни генетические

алгоритмы — суть частный случай машинного обучения [Mitchell,

1998].

Мозг животных является другим примером систем,

способных к обучению. Мозг кодирует алгоритмы поведения, и

его конструкция является важнейшим фактором в борьбе за

существование. Способность мозга к обучению является

ценным приспособительным признаком, т.к. позволяет

адаптироваться к самым разным внешним обстоятельствам за счет

накопления жизненного опыта. Соответственно, в процессе

эволюции мозг постоянно совершенствовался в своей

способности учиться и хранить накопленные знания1. Мозг человека,

к примеру, успевает накопить в процессе жизни на порядки

больше информации, чем содержится в его генотипе.

Еще одним примером обучающейся системы является

человеческая цивилизация в целом, накапливающая и передаю-

1 В мозгу высших животных экспрессируется до 80% всех генов [Lein

и др., 2007], т.е. их геном, в основном, есть спецификация конструкции

мозга.

3.1. Основные понятия

37

щая знания от поколения к поколению с помощью главного

изобретения человека — языка.

Однако разумное поведение могут проявлять не только

живые, но и искусственные системы. До недавних пор такое

поведение программировалось людьми, а компьютеры

просто исполняли заложенные в них программы. Но буквально

на наших глазах компьютеры начинают обретать способность

учиться. При этом они способны учиться в миллионы раз

быстрее, чем мозг, а также накапливать и передавать эти

знания другим машинам. И можно не сомневаться, что в

результате этой техноэволюции появится новый вид интеллекта —

машинный интеллект. И будет это не через 100 лет, а на

наших с вами глазах и с нашим участием. Буквально за

несколько последних лет компьютеры научились делать практически

все, что человек делает меньше, чем за секунду на

подсознательном уровне — освоили все виды распознавания образов.

На очереди — сознательное мышление и человеко-машинное

общение на естественном языке.

Машинный интеллект будет главной наукой XXI в.2, вслед

за физикой и смежными науками, доминировавшими в XX в.

Физика дает нам энергию и возможность производить

множество полезных вещей. Машинный интеллект сделает эти

вещи умными. Одни более, другие — менее, но окружающие нас

вещи вскоре обретут свою волю, свои цели и будут активно

взаимодействовать с нами и между собой.

Инженеры прошлого конструировали механические и

электронные машины, слепо исполняющие заложенные в них

программы. Инженеры XXI в. будут конструировать

искусственные личности, способные думать, учиться и испытывать

эмоции. А также создавать из них коллективный разум. Так и

только так мы сможем познавать самих себя, свой

собственный разум. Ибо, по выражению Ричарда Фейнмана: "Чего

не могу воссоздать, того не понимаю".

2 Вместе со смежными науками, конструирующими разные виды

интеллекта, включая интеллект биологических и социальных систем.

38

ОСНОВЫ МАШИННОГО ОБУЧЕНИЯ

3.1.2. Определения: разум, интеллект и сознание

Значения слов в языке определяются характером их

употребления. Такие важные слова, как разум, интеллект и

сознание, по-разному употребляются разными людьми, так что их

значения довольно размыты. Не претендуя особо на строгость

определений, поясним, как мы будем их понимать в этой

книге.

Начнем с более простых понятий информации и

алгоритмов ее обработки вычислительными машинами. Последние

представляют собой устройства, способные четко различать

свои отдельные состояния (хранить информацию, или

данные) и организовывать переходы между ними (обрабатывать

информацию, или исполнять алгоритмы). Если устройства

обладают этими свойствами, мы можем отвлечься от того, из

чего они построены, т.е. отвлечься от материального и

сосредоточиться на идеальном — структурах данных и

алгоритмах. Это очень удобные и плодотворные абстракции.

Например, когда мы переписываем файл из компьютера на флешку,

мы считаем, что мы его сохранили как определенный

нематериальный объект, отвлекаясь от того, что носители этого

объекта разные и подчиняются разным физическим законам.

Когда мы говорим об алгоритмах, мы отвлекаемся от

конкретных законов движения материи, с помощью которых они

осуществляются в конкретных машинах.

Для понимания алгоритмов работы мозга мы будем

рассматривать его как биологическую машину. Это звучит

непривычно, поскольку мы привыкли к относительно простым

механическим машинам и, пусть более сложным, но все равно

довольно "тупым" компьютерам. Но в этой книге машины

понимаются более широко, раз уж мы собираемся наделить их

разумом.

Определенный класс алгоритмов машинного обучения

наделяет машины способностью накапливать знания о внешнем

мире в процессе взаимодействия с ним и использовать эти

знания для достижения поставленных целей. В этой книге мы

3.1. Основные понятия

39

будем полагать родовым признаком разума его способность

ставить и достигать какие-то цели в заранее

непредсказуемых условиях. Соответственно, мы будем исходить из такого

определения:

Разум - это алгоритм усложняющегося

целенаправленного адаптивного поведения.

Способность к усложнению алгоритмов, т.е. к

машинному обучению, является, с нашей точки зрения, ключевой в

теории машинного интеллекта. Чем большими знаниями

обладает машина, тем она разумнее, и тем сложнее может быть

ее поведение.

Интеллект - это частный случай разума, когда

поведением является сам процесс мышления, т.е. случай "чистого

разума" - соответствующий критериям разумности алгоритм

управления своим собственным исполнением. Такое

определение соответствует интуитивному пониманию интеллекта как

способности решать произвольные "творческие" задачи,

алгоритм решения которых заранее неизвестен. Далее мы не

будем без нужды акцентировать различия между интеллектом

и разумом, например в привычных словосочетаниях типа

машинный интеллект.

Устоявшийся термин искусственный интеллект (или

сокращенно ИИ), под которым обычно понимают алгоритмы

решения тех или иных когнитивных задач на уровне или лучше

человека, будет употребляться преимущественно в

социальном контексте, например при обсуждении вытеснения людей

из производства.

Наконец, сознание - это субъективное ощущение

процесса мышления, способность разума или интеллекта ощущать

ход своего исполнения. Это более сложное понятие, имеющее

только косвенное отношение к теме данной книге, и мы

отложим его обсуждение до главы 5.

Поскольку алгоритмы исполняются машинами, то

логично говорить о машинном интеллекте независимо от

естественного или искусственного происхождения машины - но-

40

ОСНОВЫ МАШИННОГО ОБУЧЕНИЯ

сителя интеллекта. Разум, как и любую программу, можно

переносить с машины на машину. Иными словами, разум можно

моделировать, имитируя с той или иной точностью

соответствующие алгоритмы.

Итак, разуму соответствует определенный класс

алгоритмов, которые способны усложняться в процессе своего

взаимодействия с внешней средой. Напомним, что согласно

Колмогорову любому алгоритму А можно приписать его

сложность С (А), определяемую как наименьшая длина

реализующей этот алгоритм компьютерной программы.

Соответственно, мы получаем возможность измерять уровень интеллекта

через сложность соответствующего алгоритма.

Обучению, т.е. накоплению знаний, соответствует

повышение сложности алгоритма поведения в процессе

взаимодействия с внешней средой:

C(At)>C(Av), t>t'.

Такое взаимодействие необходимо, т.к. только оно может

служить источником новой информации, не содержавшейся в

первоначальной программе .

Полезность накапливаемых знаний определяется

способностью алгоритма к целесообразному адаптивному

взаимодействию со средой. В биологических системах, например,

максимизируется способность популяции к выживанию. В

искусственный интеллект могут быть заложены другие цели,

например различные варианты трех законов роботехники.

Если задана цель поведения, то подразумевается, что

можно отличить правильные действия от ошибочных. А

поскольку речь идет об адаптивном поведении в условиях

неопределенности, то целесообразное адаптивное поведение

характеризуется понижением вероятности ошибок со временем, т.е.

обучение минимизирует риски неправильного поведения:

C(At)<C{Atf), t>tf,

3 Без внешней среды любое состояние памяти машины At получается

автоматически, т.е. имеет ту же сложность, что и Aq.

3.1. Основные понятия

41

где С (At) — цена ошибочного поведения алгоритма А в

момент t. Таким образом, в конечном итоге важны не сами

знания, а основанное на них правильное поведение.

Очевидно, что чем сложнее алгоритм, тем шире

репертуар возможных программ поведения, и тем больше

возможности машины к достижению своих целей. Задача машинного

обучения — использовать эти возможности с максимальной

эффективностью.

3.1.3. Машинное обучение: модели

Пусть взаимодействие со средой описывается получением

некоторого набора эмпирических данных D, конкретный вид

которых нам пока не важен.

Задачей обучения является оптимальное обобщение этих

эмпирических данных, т.е. построение модели, позволяющей

предсказывать новые события D' и правильно реагировать на

них, основываясь на известном опыте прошлого. Такие

предсказания в общем случае носят вероятностный характер:

обобщением имеющегося набора данных служит некая гипотеза

h — модель вероятностного порождения данных P(D\h).

Насколько хорошо эта гипотеза соответствует

наблюдаемым данным D, определяется т.н. эмпирическим риском L(D\h).

Эмпирический риск можно измерять в битах — сколько

памяти требуется для кодирования ошибок модели. Чем точнее

модель, тем меньше L(D\h), тем компактнее кодируются

наблюдаемые данные с помощью модели.

Как мы вскоре убедимся, обучение теснейшим образом

связано со сжатием данных с помощью моделей.

Действительно, случайные данные несжимаемы. Любое сжатие данных

основано на присущих им закономерностях. Чем больше

закономерностей мы сможем обнаружить, тем большего сжатия

данных удается достичь и тем сильнее предсказательная

способность нашей модели.

Естественно, мы хотим, чтобы выбранная нами гипотеза

h являлась наилучшим возможным приближением к реально-

42

ОСНОВЫ МАШИННОГО ОБУЧЕНИЯ

сти. А именно, чтобы она минимизировала ожидаемую

среднюю ошибку предсказания данных с ее помощью, т.н. ошибку

обобщения:

C0(h) = (L(D\h))P{Dlhoy (3.1)

Здесь ho — истинная модель порождения данных, а

усреднение производится по всем возможным выборкам данных

одинакового размера \D\. Проблема состоит в том, что нам

она неизвестна и может даже не принадлежать к выбранному

нами классу гипотез. Таким образом, ошибка обобщения —

это ненаблюдаемая величина. То есть мы хотим

оптимизировать то, что не можем измерить. В этом и состоит

фундаментальная проблема теории обучения, т.к. оптимизировать мы

можем лишь измеримые величины.

Таковой является наилучшее в выбранном классе гипотез

приближение к (3.1):

C(h) = (L(D\h))P{Dlh). (3.2)

Ее-то мы минимизировать можем. Для этого достаточно,

чтобы более вероятные наборы данных предсказывались

лучше, чем более редкие. А именно, эмпирический риск должен

быть связан с вероятностью порождения данных

соотношением:

L(D\h) = -log P(D\h) + const, (3.3)

где const — нормировочная константа, а логарифм берется по

основанию 2, если мы измеряем риск в битах.

Действительно, согласно известной теореме Шеннона об

оптимальном кодировании, средняя длина закодированного

сообщения будет минимальной, если длина кода символов L{x)

связана с их частотой Р(х) соотношением L(x) = — logP(x) +

const, т.е. чем чаще встречается символ, тем короче должен

быть его двоичный код. Любой другой код приведет к

большей ожидаемой длине сообщения.

Таким образом, если мы умеем измерять эмпирический

риск L(D\h), мы можем определить и оптимальную модель

3.1. Основные понятия

43

порождения данных P(D\h) согласно (3.3), минимизирующую

оценку ошибки обобщения (3.2).

Таким образом, оптимальной гипотезе соответствует

максимальное сжатие данных. Развивая эту мысль, мы можем

подбирать и оптимальную сложность моделей.

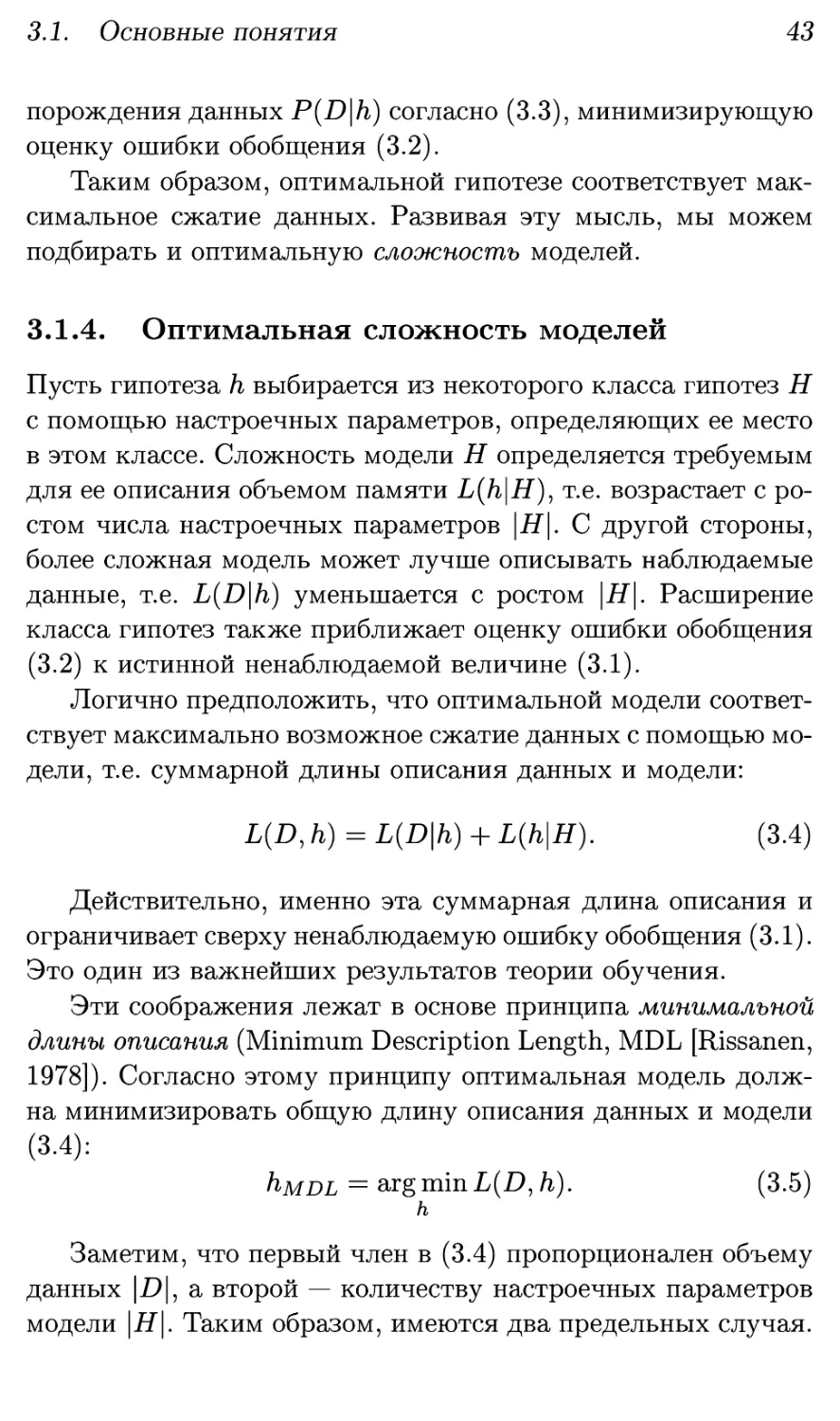

3.1.4. Оптимальная сложность моделей

Пусть гипотеза h выбирается из некоторого класса гипотез Н

с помощью настроечных параметров, определяющих ее место

в этом классе. Сложность модели Н определяется требуемым

для ее описания объемом памяти L(h\H), т.е. возрастает с

ростом числа настроечных параметров \Н\. С другой стороны,

более сложная модель может лучше описывать наблюдаемые

данные, т.е. L(D\h) уменьшается с ростом \Н\. Расширение

класса гипотез также приближает оценку ошибки обобщения

(3.2) к истинной ненаблюдаемой величине (3.1).

Логично предположить, что оптимальной модели

соответствует максимально возможное сжатие данных с помощью

модели, т.е. суммарной длины описания данных и модели:

L(D, h) = L(D\h) + L{h\H). (3.4)

Действительно, именно эта суммарная длина описания и

ограничивает сверху ненаблюдаемую ошибку обобщения (3.1).

Это один из важнейших результатов теории обучения.

Эти соображения лежат в основе принципа минимальной

длины описания (Minimum Description Length, MDL [Rissanen,

1978]). Согласно этому принципу оптимальная модель

должна минимизировать общую длину описания данных и модели

(3.4):

hMDL = argminL(L>,/i). (3.5)

h

Заметим, что первый член в (3.4) пропорционален объему

данных \D\, а второй — количеству настроечных параметров

модели |Д"|. Таким образом, имеются два предельных случая.

44

ОСНОВЫ МАШИННОГО ОБУЧЕНИЯ

Если число параметров модели мало по сравнению с

объемом обучающей выборки, |Д"| <^ |D|, то длиной описания

модели в (3.4) можно пренебречь, и мы можем просто

минимизировать наблюдаемую ошибку обучения. Это

традиционный подход математической статистики. Соответствующий

критерий оптимальности известен как принцип максимума

правдоподобия (Maximum Likelihood, ML):

hjML = sigmin L(D\h) = argmaxP(£)|/i). (3.6)

h h

Для простых статистических моделей типа линейной

регрессии и относительно большого числа данных это

приближение отлично работает. Однако слишком простые модели не

оптимальны, если имеющийся объем данных позволяет

обучить более сложные модели с меньшей ошибкой

предсказаний.

В противоположном пределе слишком сложных моделей

с \Н\ ^> |£)|, характерном для современных глубоких нейро-

сетей, содержащих подчас сотни миллионов параметров,

возникает т.н. проблема переобучения (overfitting): большое число

параметров позволяет уменьшать ошибку обучения вплоть до

нуля, т.е. попросту запоминать конкретные наборы данных,

вместо того, чтобы обобщать их. Переобученная модель не

имеет никакого отношения к истинной и может иметь

большую ошибку обобщения. Поэтому обучение достаточно

сложных моделей необходимо регуляризироватъ, накладывая на

их параметры различные ограничения, искусственно

снижающие сложность модели. Регуляризация обучения — одна из

сквозных тем теории машинного обучения, и далее мы будем

к ней постоянно возвращаться.

Идеальное обучение использует модели оптимальной

сложности, соответствующие принципу минимальной длины

описания. Такие модели обладают наилучшей предсказательной

силой. Именно суммарная длина описания L(D,/i), согласно

3.1. Основные понятия

45

Vapnik, 1998, ограничивает ненаблюдаемую среднюю

ожидаемую ошибку на новых данных:4

Co(h) <2-L(D,h). (3.7)

Еще один глубокий результат теории обучения — оценка

оптимальной сложности модели. Согласно Rissanen, 1978

длина описания оптимальной модели равна

L(hMDL\H) = \H\ log y/\D\. (3.8)

Таким образом, сложность алгоритма действительно

возрастает по мере обучения, однако скорость накопления

знаний падает с ростом числа примеров. То есть быстрее

всего мы учимся на начальных стадиях обучения (в детстве),

а дальнейшее совершенствование модели достигается со все

большим трудом.

При конечном объеме данных точность определения

параметров модели всегда конечна: среднее число бит на степень

свободы равно log y|^D|. Более точное задание параметров

есть превышение точности: имеющийся набор данных не

позволяет определить их точнее. Следовательно, результат

обучения дается не точкой, а множеством в пространстве

параметров, объем которого определяет (3.8). Определить и

использовать его форму позволяет наиболее общая,

байесовская, трактовка обучения.

3.1.5. Байесова трактовка обучения

Выше мы рассмотрели выбор оптимальной модели

порождения данных P(D\h). Обучение в более общей постановке

предполагает решение обратной задачи: по имеющимся данным

4 Точнее, с вероятностью не меньшей 1 — rj: £o(h) < 2[L(D, h) — log77].

Для достаточно сложных моделей и больших массивов данных

L(D,h) ^> 1 и последним членом в правой части можно пренебречь,

т.е в широком диапазоне параметра уверенности rj мы получаем оценку

(3.7). Вапник также показал, что эту оценку нельзя улучшить более чем

вдвое.

46

ОСНОВЫ МАШИННОГО ОБУЧЕНИЯ

выяснить вероятность различных гипотез о способе

порождения этих данных P(h\D). Это и есть то самое множество

гипотез, о котором шла речь выше.

Байесов подход к обучению, основанный на решении

обратной задачи, наиболее последователен, при том что в

общем виде она решается ав одну строку", и это решение,

следующее из общих принципов теории вероятностей, было

известно уже в XVIII в. Действительно, если трактовать как

выбор гипотезы, так и наблюдение данных в вероятностном

смысле и записать согласно определению условных

вероятностей P(D,h) = P(h\D)P(D) = P(D\h)P(h), получим теорему

преподобного Байеса:

F^D)- P(D) ~ ZhP(D\h)P(hY {™}

Для фиксации терминологии запишем эту

основополагающую формулу в словесном виде:

_ . Likelihood • Prior

Posterior = . .

Evidence

Как видим, решение обратной задачи требует

формализации наших априорных (prior) предположений P(h) о степени

вероятности той или иной гипотезы. Подобного рода

ограничение на множество гипотез, в котором ищется решение, в

теории обратных задач называют регуляризацией.

Нетрудно заметить, что байесовский подход к обучению

соответствует принципу минимальной длины описания. Так,

наиболее вероятная гипотеза (Maximum Posterior)

соответствует наиболее компактному представлению данных:

hMP = argminL(/i|£>) = aigmm[L(D\h) + L(h) - L(D)} =

h h

= arg min [L(D | h) + L(h)] = hMDL-

h

3.1. Основные понятия 4 7

Гипотезы всегда выбираются в рамках той или иной

модели Н, от которой зависят все вероятности в (3.9):

РШП т_РШ,Н)Р{ЩН)

Р(/г|дя)- рЩИ) •

Фундаментальный характер теоремы Байеса позволяет в

едином ключе сравнивать между собой не только гипотезы

/i, ной различные модели регуляризации Н. Насколько

правдоподобно выглядит объяснение данных моделью определяет

знаменатель формулы Байеса

P(D\H) = £ft P(D\h, H)P(h\H) = Y,h P(D, h\H). (3.10)

Поэтому его и называют Evidence, т.е. правдоподобие или

обоснованность данной модели Н. Принцип максимизации

Evidence позволяет не только определить апостериорное

распределение гипотез в рамках заданной модели, но и выбрать

модель оптимальной сложности, которая лучше других

объясняет имеющиеся данные.

3.1.6. Ансамбли гипотез

Подчеркнем, что оптимальная модель, по Байесу, состоит из

ансамбля гипотез. Считается, что в предсказаниях участвуют

все гипотезы, каждая со своей апостериорной вероятностью.

И это действительно имеет смысл, т.к. легко показать, что

ансамбль в целом обладает лучшей обобщающей способностью,

чем любой из его представителей, включая наиболее

вероятную гипотезу.

Действительно, длина описания данных с помощью всего

ансамбля меньше, чем длина описания с помощью наилучшей

гипотезы:

L(D\H) = - log P(D\H) = -log^ftP(A Л|Я) <

< - log P(D, hMp\H) = L (D, hMp\H),

48

ОСНОВЫ МАШИННОГО ОБУЧЕНИЯ

поскольку любой член суммы положительных слагаемых под

логарифмом меньше, чем вся сумма. Следовательно, и

обобщающая способность предсказаний с помощью ансамбля

выше, чем обобщающая способность любой, даже наилучшей из

его гипотез! Действительно, каждая из апостериорных

гипотез страдает в той или иной степени от переобучения. Всегда

можно предложить примеры, на которых она будет давать

неправильные предсказания. Ансамбль в целом, подобно

коллективу экспертов, более устойчив к переобучению и

обладает лучшей предсказательной способностью. Качественно этот

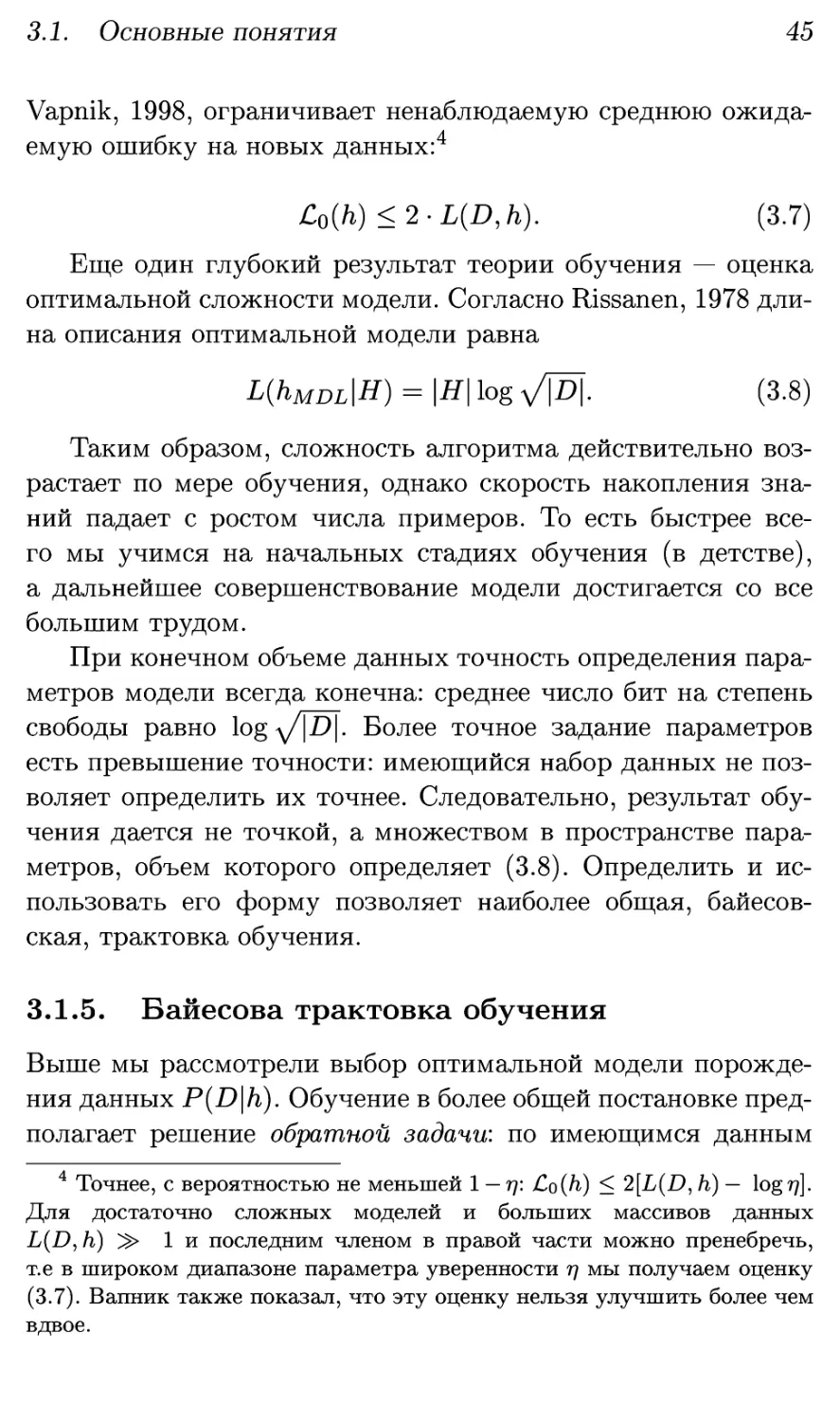

факт иллюстрирует рис. 3.1.

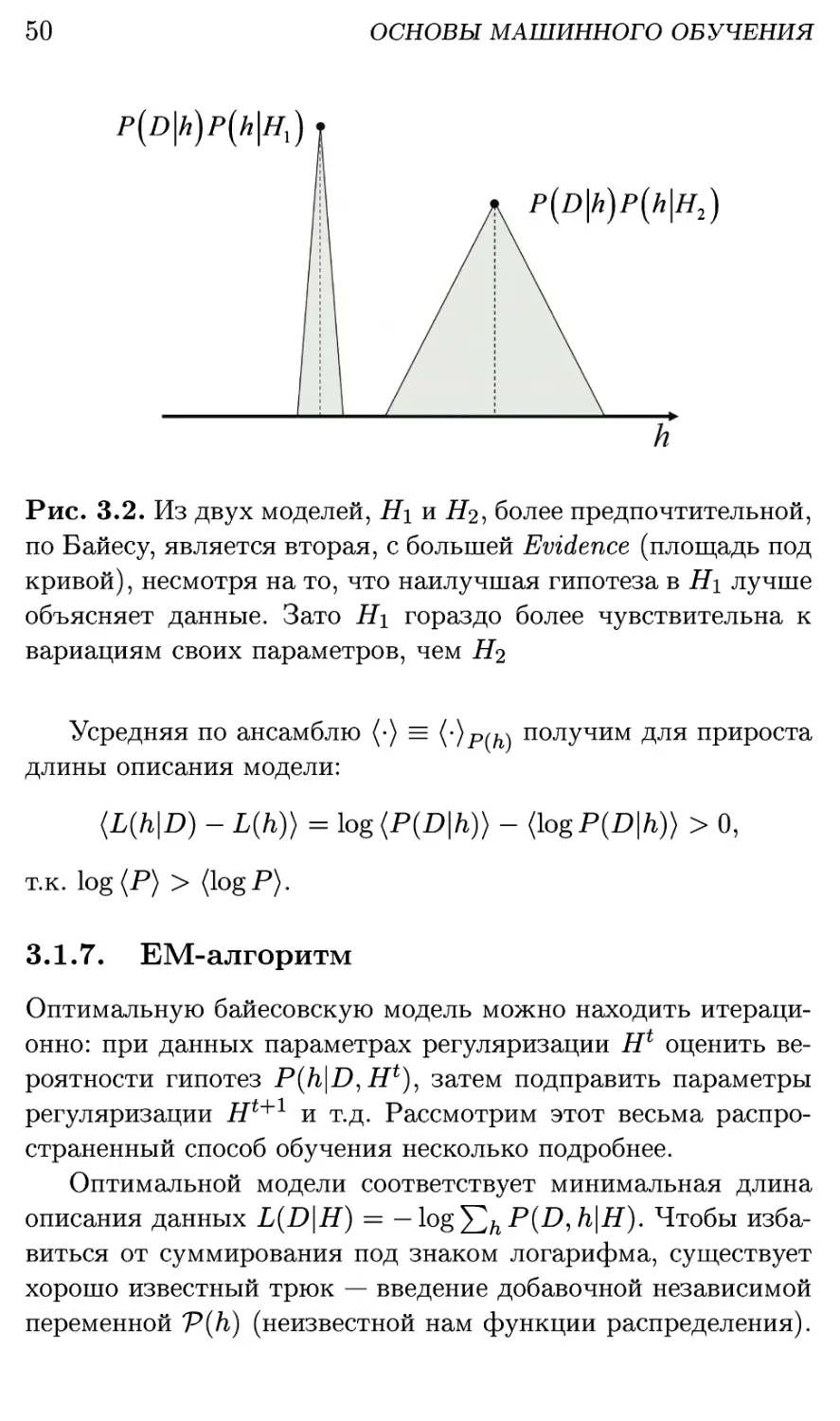

При таком подходе вполне естественно, что наилучшей

моделью считается не та, в которой существует наиболее

правдоподобная гипотеза, а та, в которой доля правдоподобных

гипотез достаточно велика. Максимизация Evidence

выражает именно эту точку зрения (см. рис. 3.2). Поскольку

интеграл Evidence определяется не только высотой, но и шириной

апостериорного пика в пространстве гипотез, то наиболее

вероятная гипотеза в оптимальной, по Байесу, модели должна

не просто соответствовать данным, но и быть одновременно

наиболее робастной, т.е. наименее чувствительной к

вариациям своих параметров.

Можно сказать, что максимизация Evidence реализует

известный принцип бритвы Оккама: предпочтение отдается

наиболее простой модели, способной объяснить эмпирические

данные. Этот факт иллюстрирует рис. 3.3. Как видно из этого

рисунка, байесовский подход отсеивает не только модели, не

соответствующие наблюдаемым данным, но и излишне сложные

модели, могущие объяснить большее разнообразие данных5.

Байесово обучение накапливает знания кумулятивно. С

каждой новой порцией данных облако гипотез становится все

5 Модели, которые в принципе могут объяснить любые данные,

К. Поппер предлагал считать "ненаучными", т.к. никакой эксперимент

не в состоянии их опровергнуть. По Байесу, в силу условия нормировки,

их Evidence, действительно, стремится к нулю.

3.1. Основные понятия

49

к

Рис. 3.1. Иллюстрация байесовского подхода к

предсказаниям. Данные представляют собой набор точек из двух классов.

Гипотеза классифицирует данные в соответствии с их

расположением относительно линии разделения классов, в данном

случае — прямой. Звездой отмечена новая точка,

отсутствующая в обучающей выборке. Наиболее вероятная гипотеза кмр

классифицирует эту точку как «круг». Однако, среди

других возможных гипотез нет единства: некоторые, такие как

/ii, голосуют за «крест», другие, как h<i - за «круг». Тем

самым, предсказание ансамблем гипотез дает возможность

понять, что новая точка лежит далеко от обучающей выборки

и оценить надежность ее классификации

более компактным. Априорной функцией для следующего

этапа обучения служит апостериорная функция предыдущего

этапа. При этом на каждом этапе происходит накопление

знаний, т.к. длина описания модели увеличивается.

Действительно, из формулы Байеса (3.9) для разницы длины описания

апостериорной и априорной гипотез имеем:

L{h\D) - L(h) = L(D\h) - L(D).

50

ОСНОВЫ МАШИННОГО ОБУЧЕНИЯ

P(D\h)P(h\Hx)

P(D\h)p(h\H2)

Рис. 3.2. Из двух моделей, Н\ и #2, более предпочтительной,

по Байесу, является вторая, с большей Evidence (площадь под

кривой), несмотря на то, что наилучшая гипотеза в Hi лучше

объясняет данные. Зато Hi гораздо более чувствительна к

вариациям своих параметров, чем Н^

Усредняя по ансамблю (•) = (-)р(м получим для прироста

длины описания модели:

(L(h\D) - L(h)) = log (P(D\h)) - (log P(D\h)) > 0,

т.к. log(P) > (logP).

3.1.7. EM-алгоритм

Оптимальную байесовскую модель можно находить

итерационно: при данных параметрах регуляризации Н1 оценить

вероятности гипотез P{h\D,Hl), затем подправить параметры

регуляризации

Ht+i

и т.д. Рассмотрим этот весьма

распространенный способ обучения несколько подробнее.

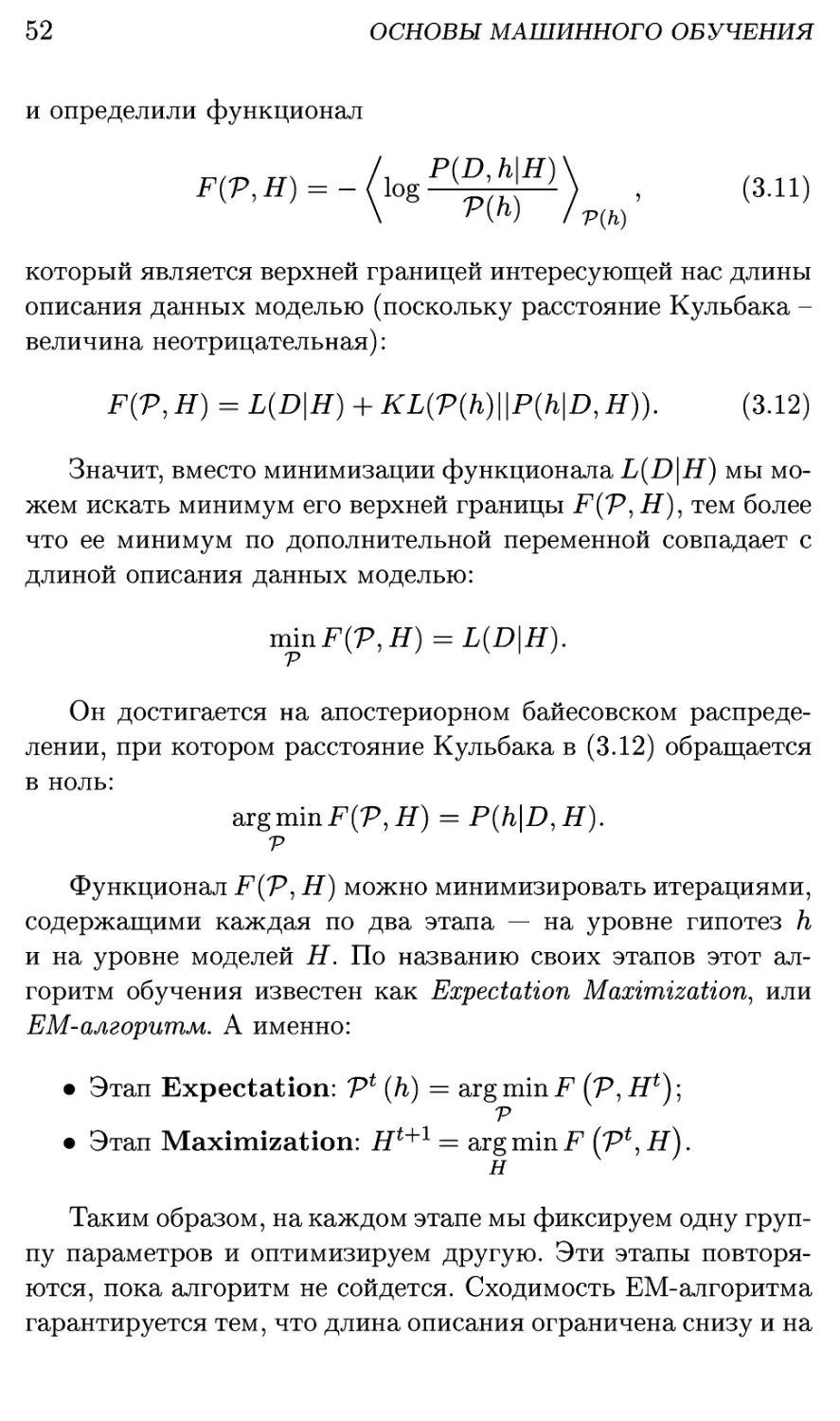

Оптимальной модели соответствует минимальная длина

описания данных L{D\H) — —log^2hP(D,h\H). Чтобы

избавиться от суммирования под знаком логарифма, существует

хорошо известный трюк — введение добавочной независимой

переменной V(h) (неизвестной нам функции распределения).

3.1. Основные понятия

51

Рис. 3.3. Максимизация Evidence предполагает выбор

наиболее простой модели объяснения данных. Модель Н\ не

соответствует данным Do. Модель Н% может объяснить не только

имеющиеся данные, но и широкий круг других исходов

эксперимента. Условие нормировки автоматически понижает ее

Evidence. По Байесу, эмпирические данные свидетельствуют

в пользу модели Н^

Усредняя по этой функции распределения независящую от нее

L[D\H\ получим следующее тождество:

= -/logPWft|g)\ -/log PW \ _

\ g P(h) )v(k) \ eP(h\D,H)/rm

= F(V,H) - KL(V(h)\\P(h\D,H)).

Здесь в первой строчке мы воспользовались

определением совместной вероятности P(D,h\H) = P(h\D,H)P(D\H), a

во второй - определением расстояния Кульбака между двумя

распределениями:

кцчьшн)) = (**%$)

52

ОСНОВЫ МАШИННОГО ОБУЧЕНИЯ

и определили функционал

который является верхней границей интересующей нас длины

описания данных моделью (поскольку расстояние Кульбака -

величина неотрицательная):

F(V, H) = L(D\H) + KL(V(h)\\P(h\D, Я)). (3.12)

Значит, вместо минимизации функционала L(D\H) мы

можем искать минимум его верхней границы F(V, H), тем более

что ее минимум по дополнительной переменной совпадает с

длиной описания данных моделью:

minF(V,H) = L(D\H).

Он достигается на апостериорном байесовском

распределении, при котором расстояние Кульбака в (3.12) обращается

в ноль:

argminF(P,#) = P(h\D,H).

v

Функционал F(V, H) можно минимизировать итерациями,

содержащими каждая по два этапа — на уровне гипотез h

и на уровне моделей Н. По названию своих этапов этот

алгоритм обучения известен как Expectation Maximization, или

ЕМ-алгоритм. А именно:

• Этап Expectation: Vl (h) = argminF (Р,Я*);

V

• Этап Maximization: ift+1 = argminF (Тг,Н).

н

Таким образом, на каждом этапе мы фиксируем одну

группу параметров и оптимизируем другую. Эти этапы

повторяются, пока алгоритм не сойдется. Сходимость ЕМ-алгоритма

гарантируется тем, что длина описания ограничена снизу и на

3.1. Основные понятия

53

каждом шаге не возрастает. Названия этапов определяются их

содержанием.

На этапе Expectation производится оценка

апостериорной функции распределения гипотез при текущих параметрах

регуляризации. Ответ дается формулой Байеса:

_ PPM*)

1 W P(D\H*) ■

На этапе Maximization производится уточнение

параметров регуляризации максимизацией усредненной по Байесу

длины описания данных и гипотез, как это следует из (3.11):

Ht+i

= argmin(L(D,/i \H))vt — argmax(logP(D,/i \H))vt.

н н

Таким образом, ценой введения дополнительной

переменной V(h) мы избавились от суммирования под знаком

логарифма. Усреднение логарифмов в последнем выражении —

потенциально гораздо более простая задача.

Те, кто изучал статистическую физику, легко заметят

аналогию функционалов L(D\H) и F(V,H) со свободной

энергией. При этом первый определен через логарифм

статистической суммы: L(D\H) = — log^2h e~L(DMH) c единичной

температурой, а второй - известным термодинамическим

соотношением между свободной энергией, средней энергией и

энтропией: F = Е — TS, справедливым для равновесного

канонического ансамбля в стационарной точке ЕМ-алгоритма (также с

Г=1).

Заметим, что, как и любой другой градиентный способ

обучения, ЕМ-алгоритм сходится к локальному минимуму, не

обязательно совпадающему с глобальным. Физическая

аналогия - застревание в метастабильном энергетическом

состоянии. Отсюда напрашивается естественный метод отжига -

введение эффективной температуры и ее постепенное

понижение до Г = 1 для увеличения вероятности достижения

глобального минимума [Ueda и Nakano, 1998].

54

ОСНОВЫ МАШИННОГО ОБУЧЕНИЯ

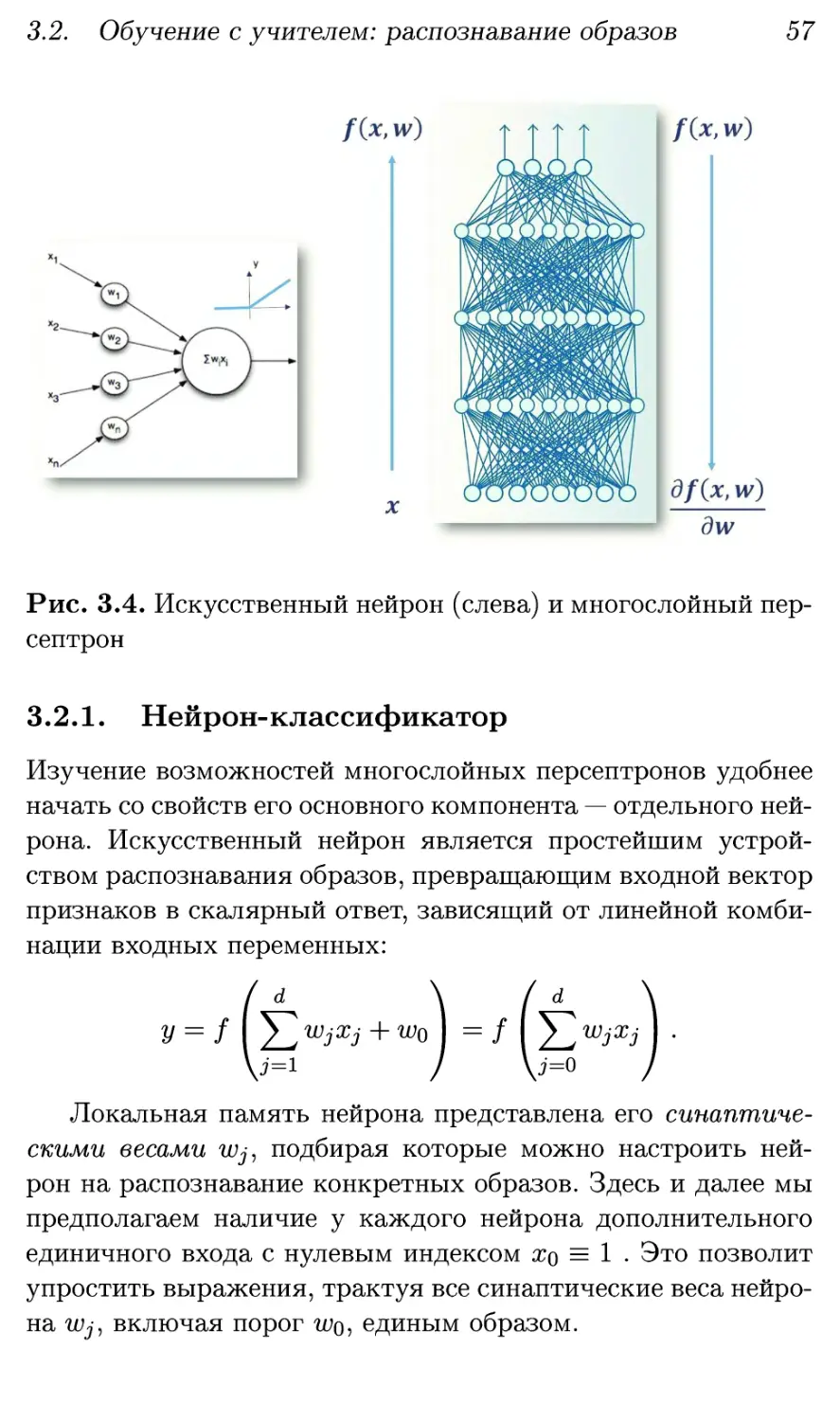

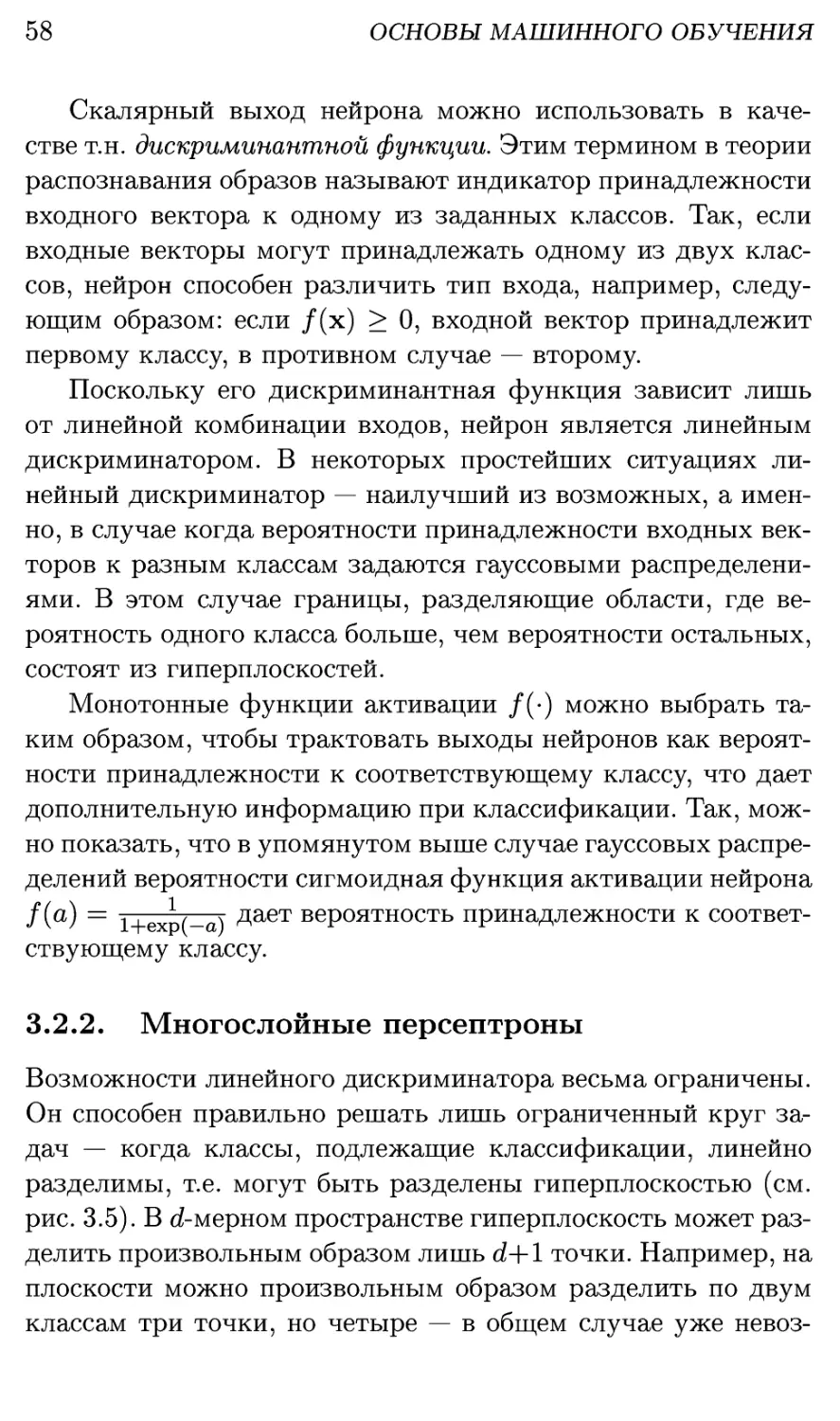

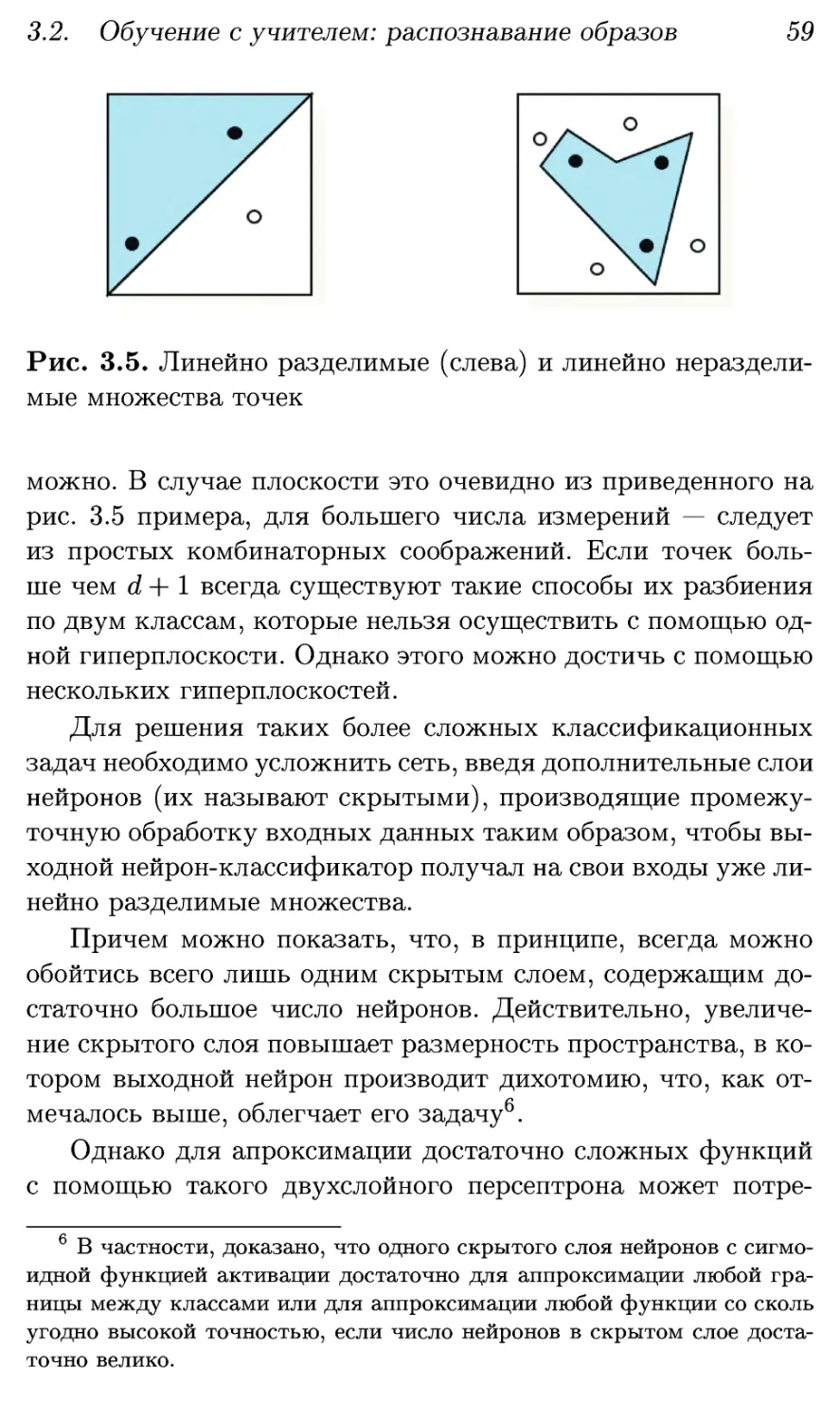

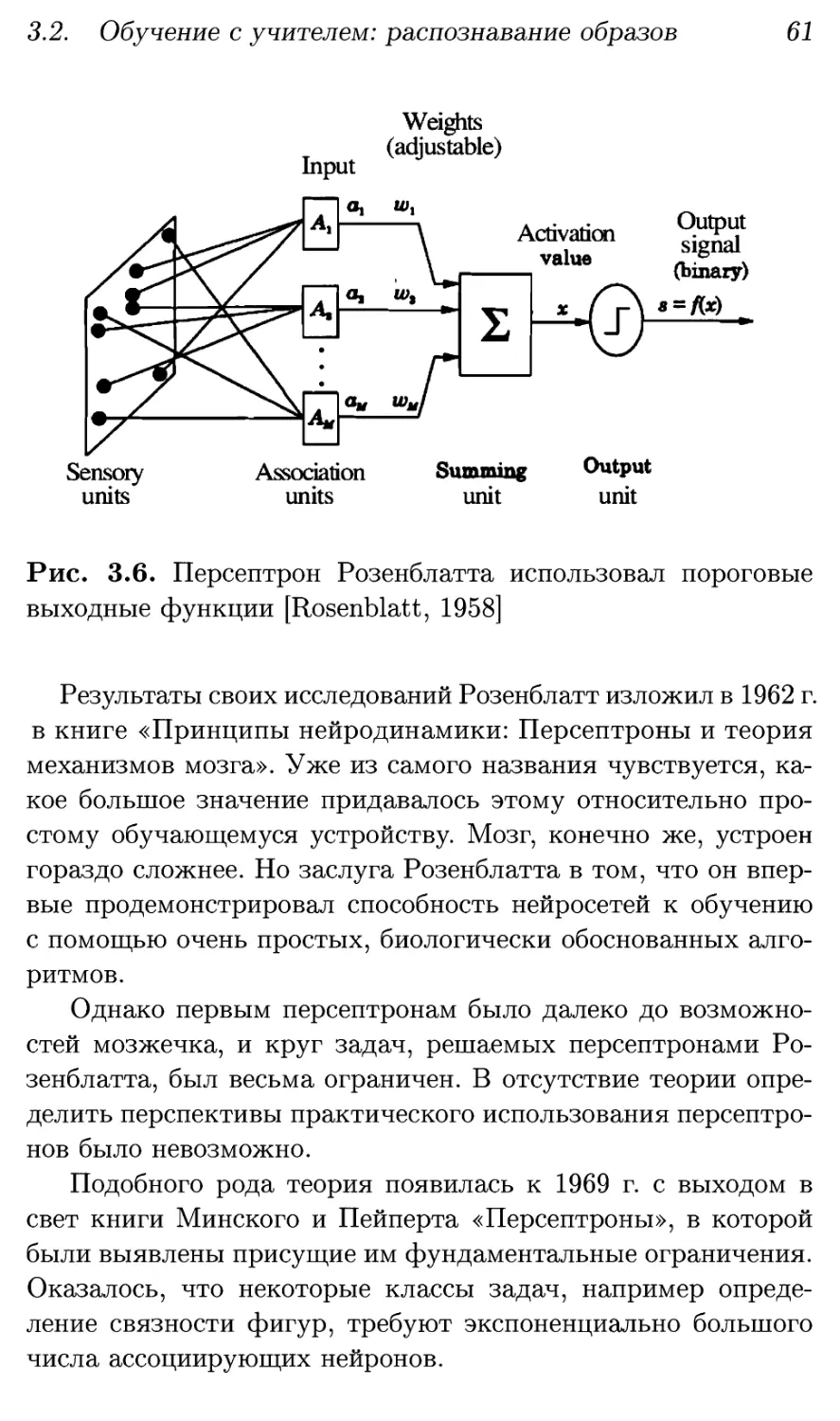

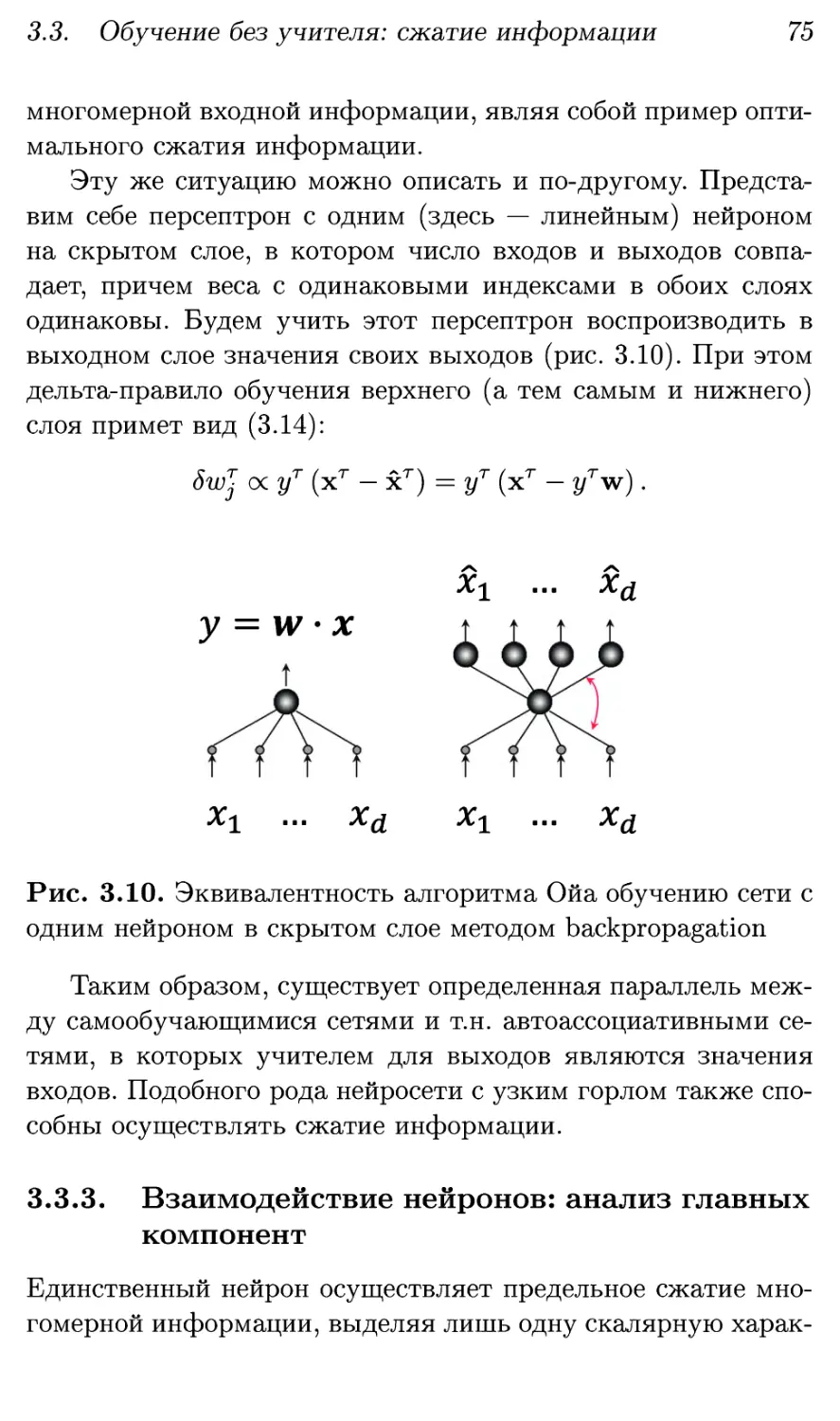

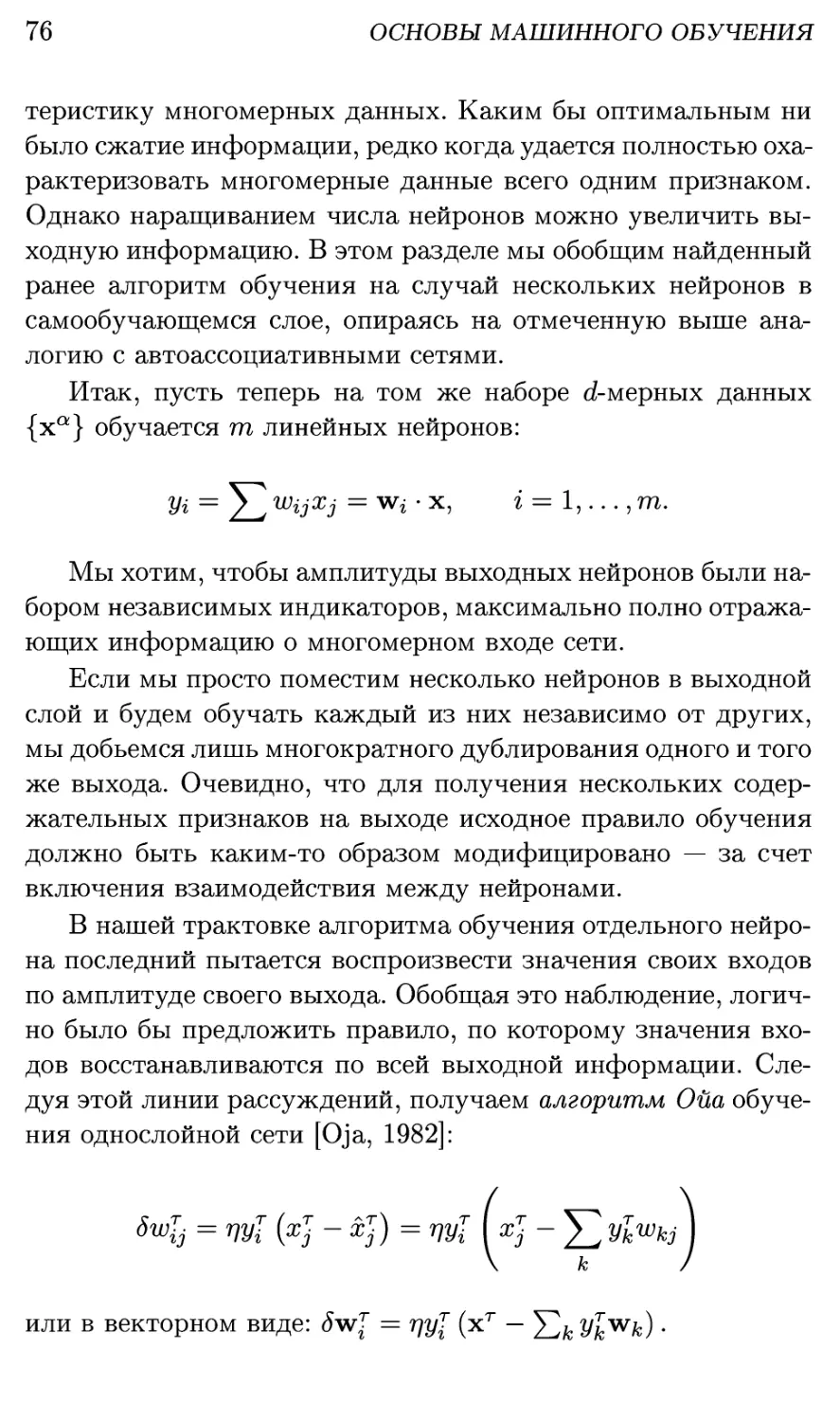

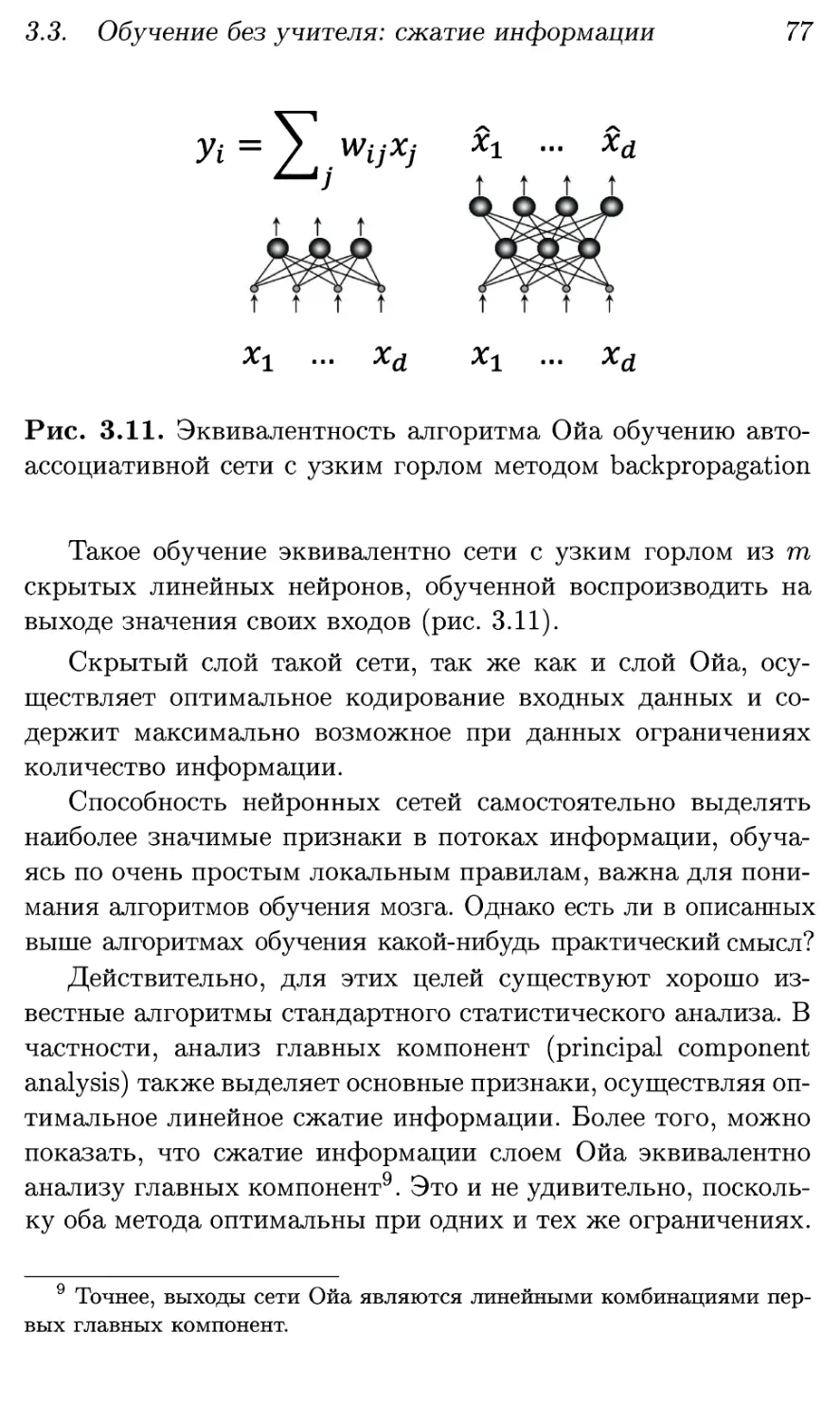

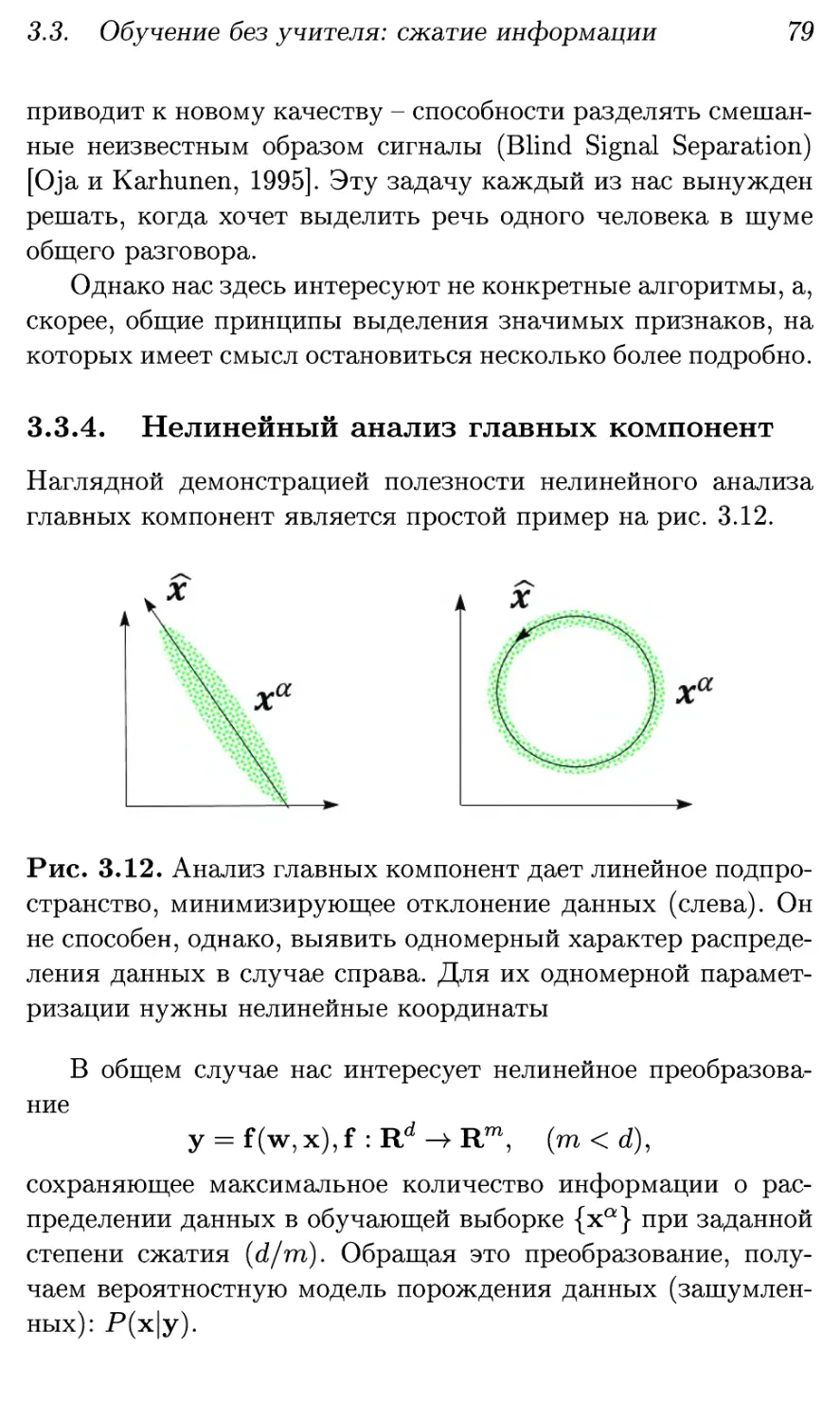

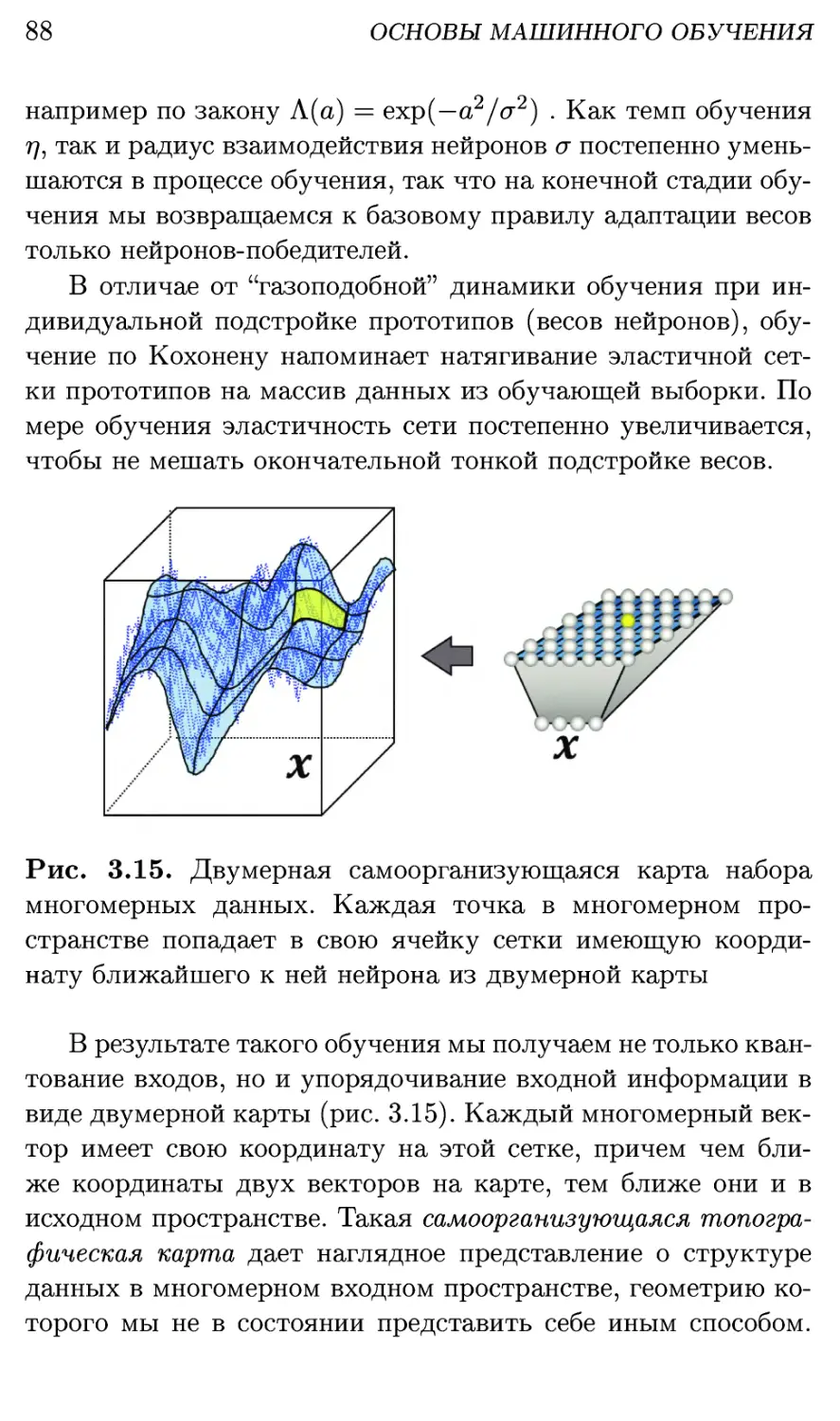

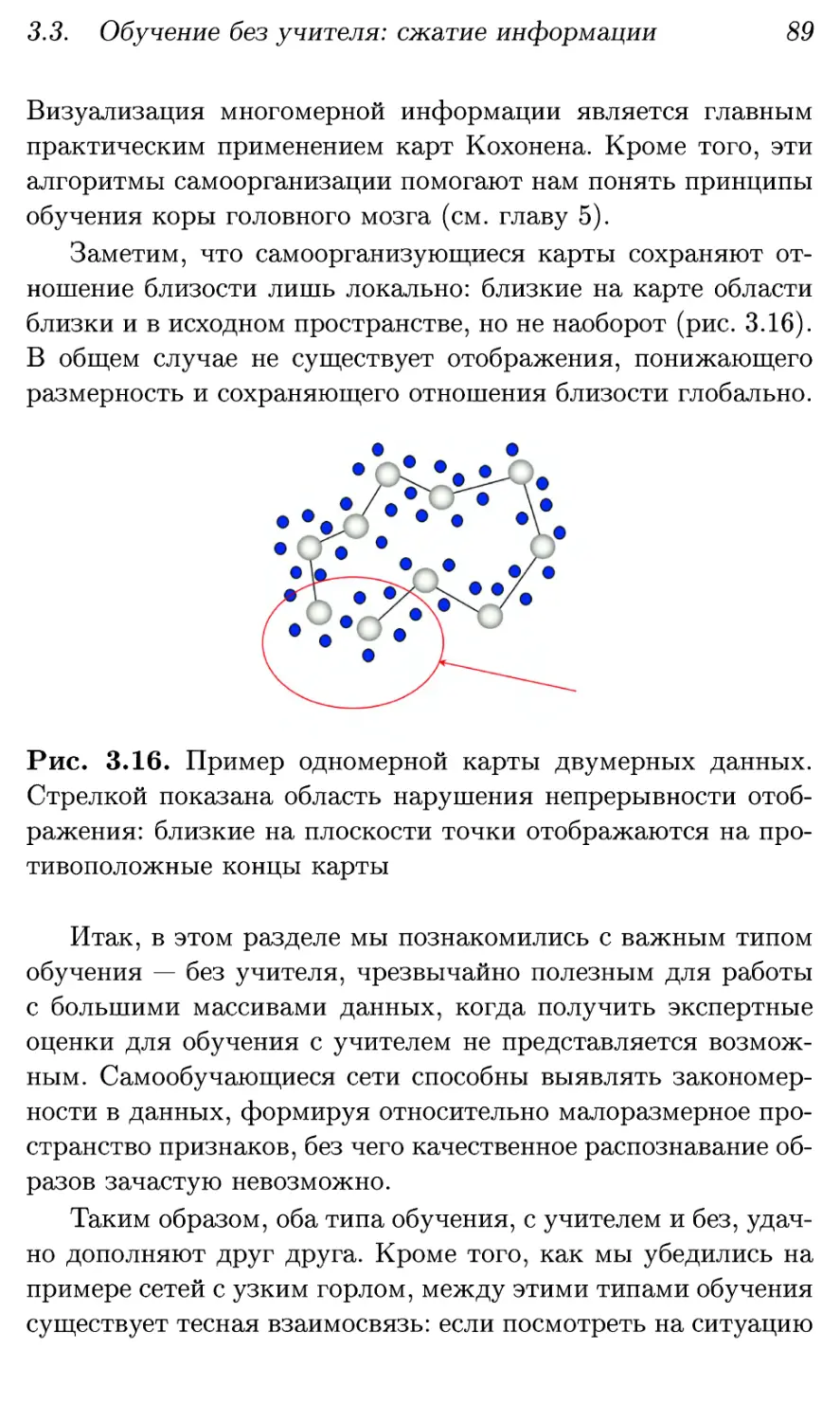

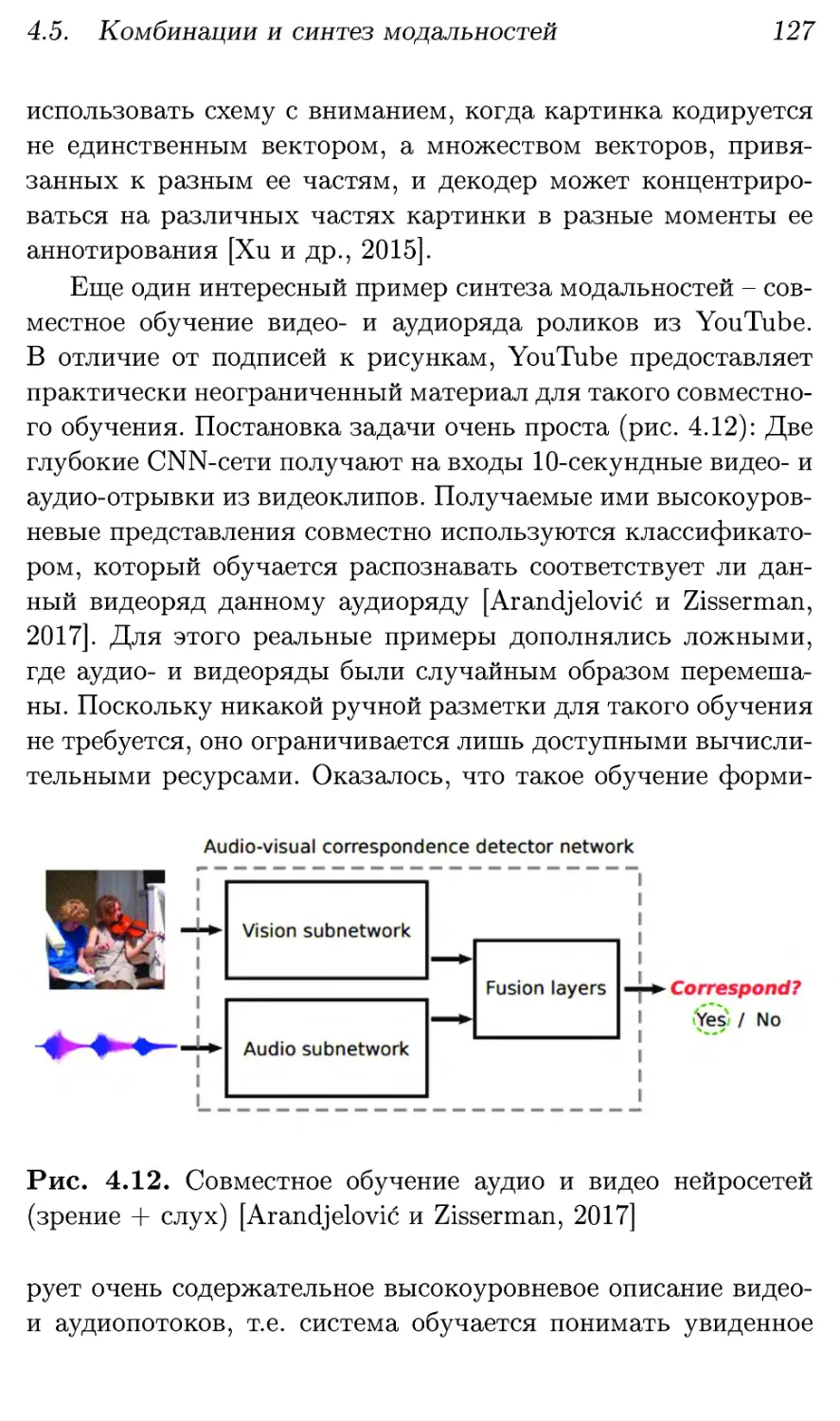

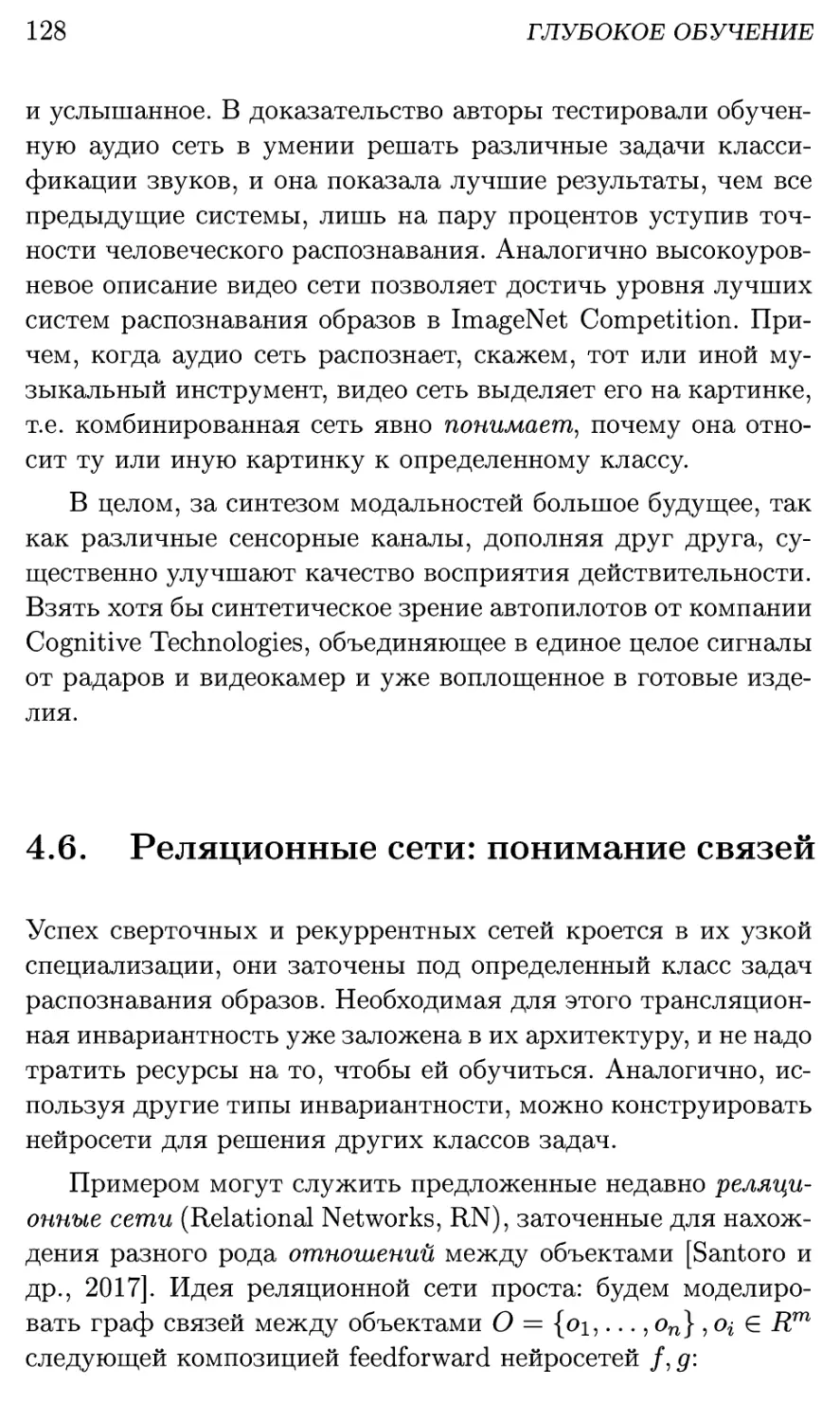

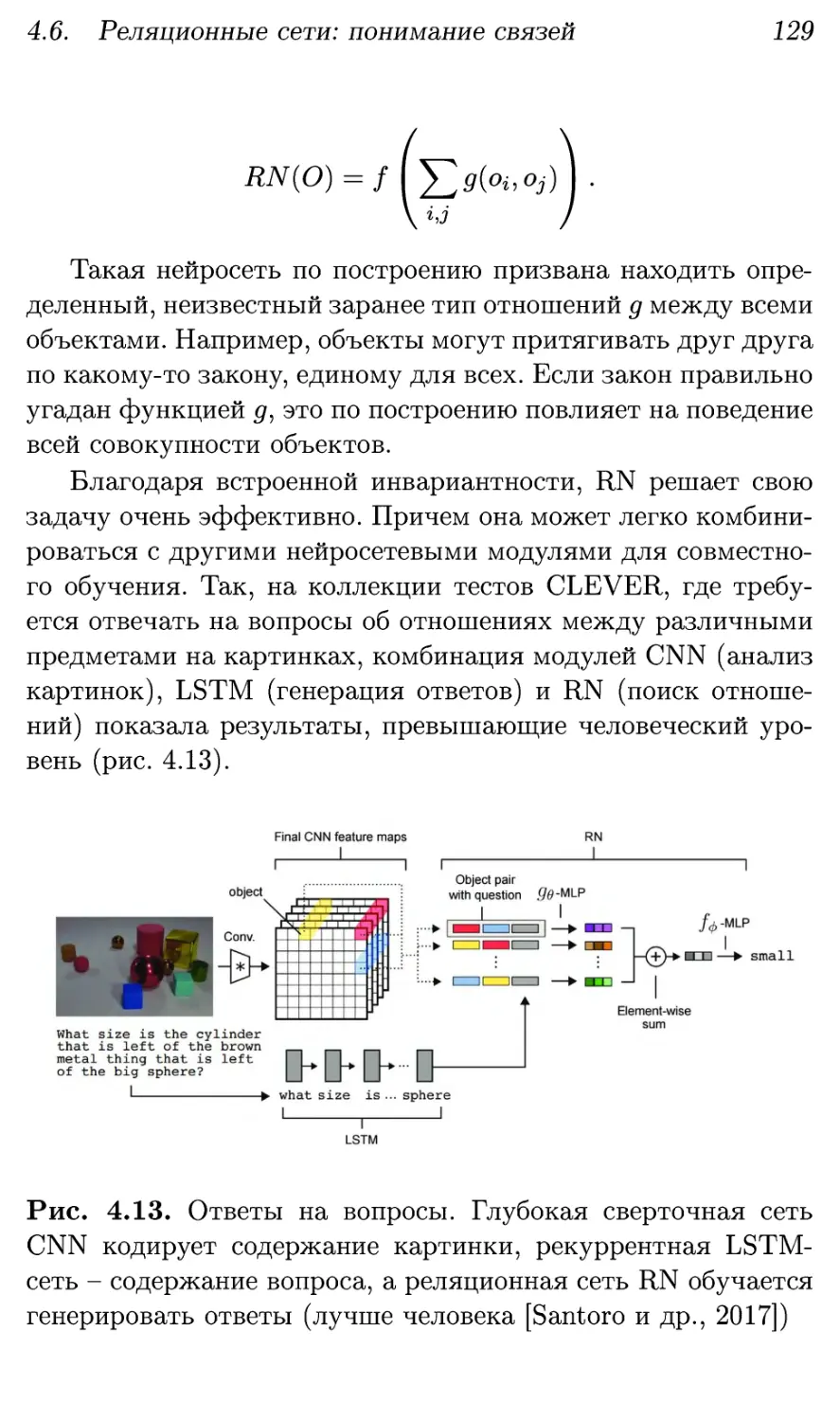

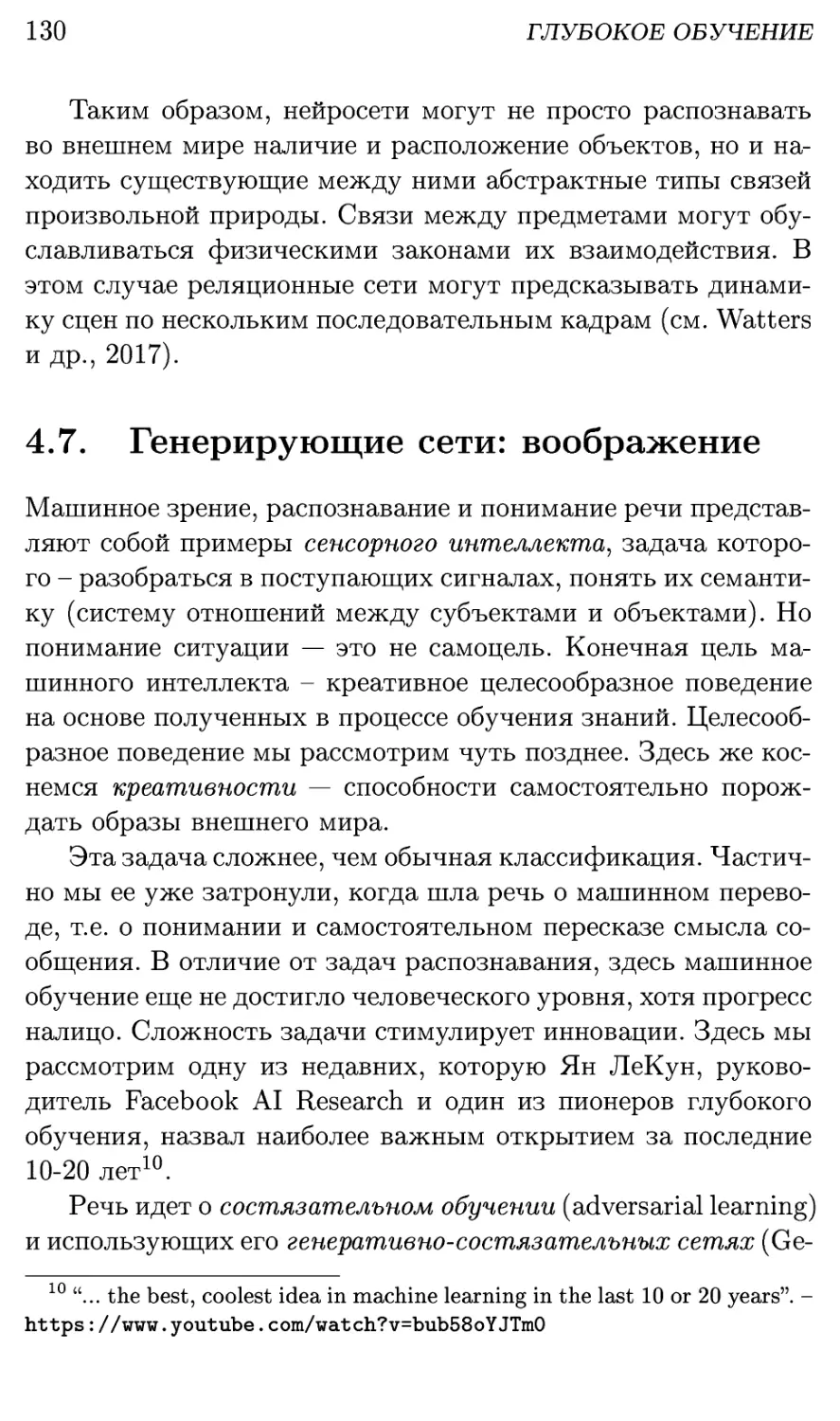

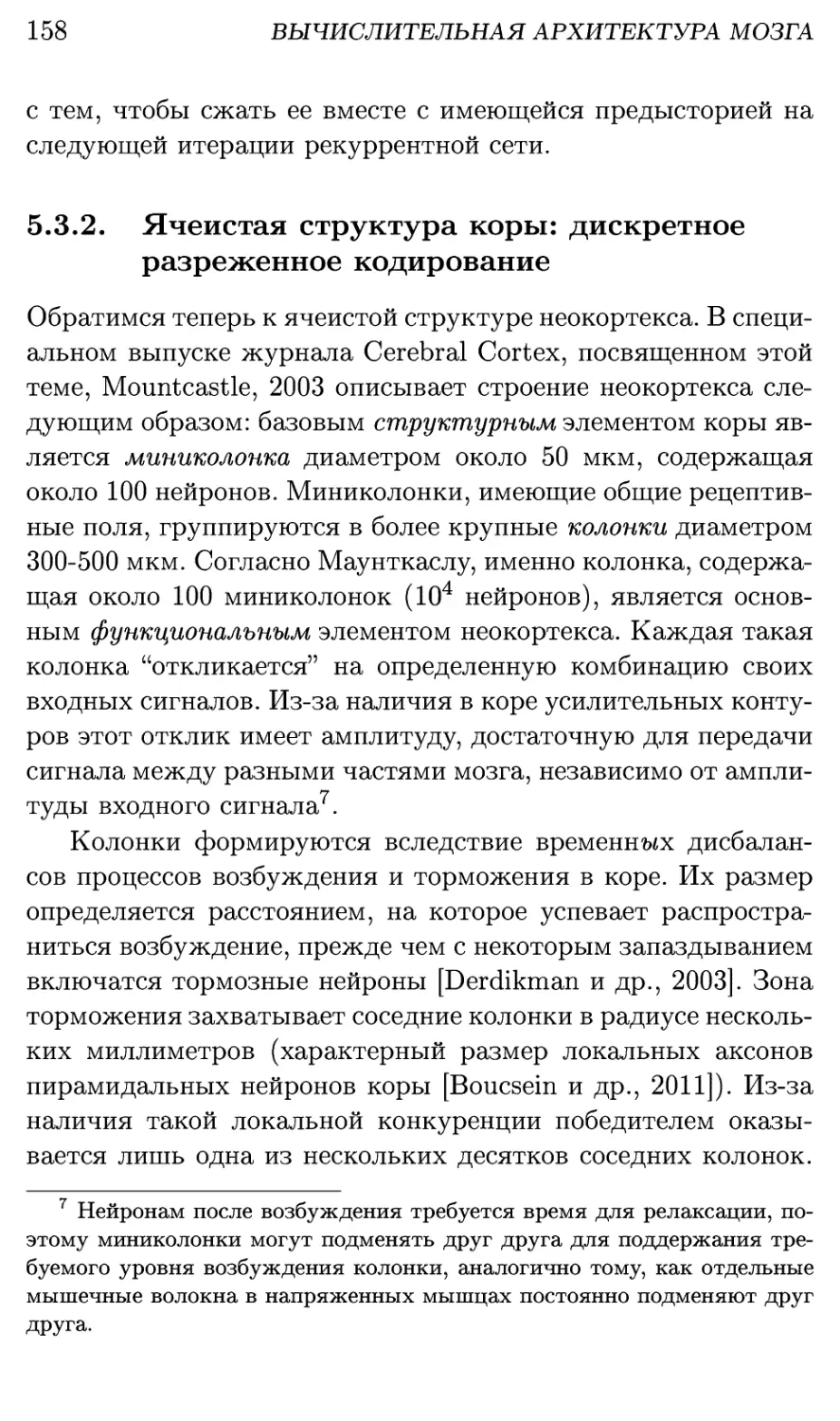

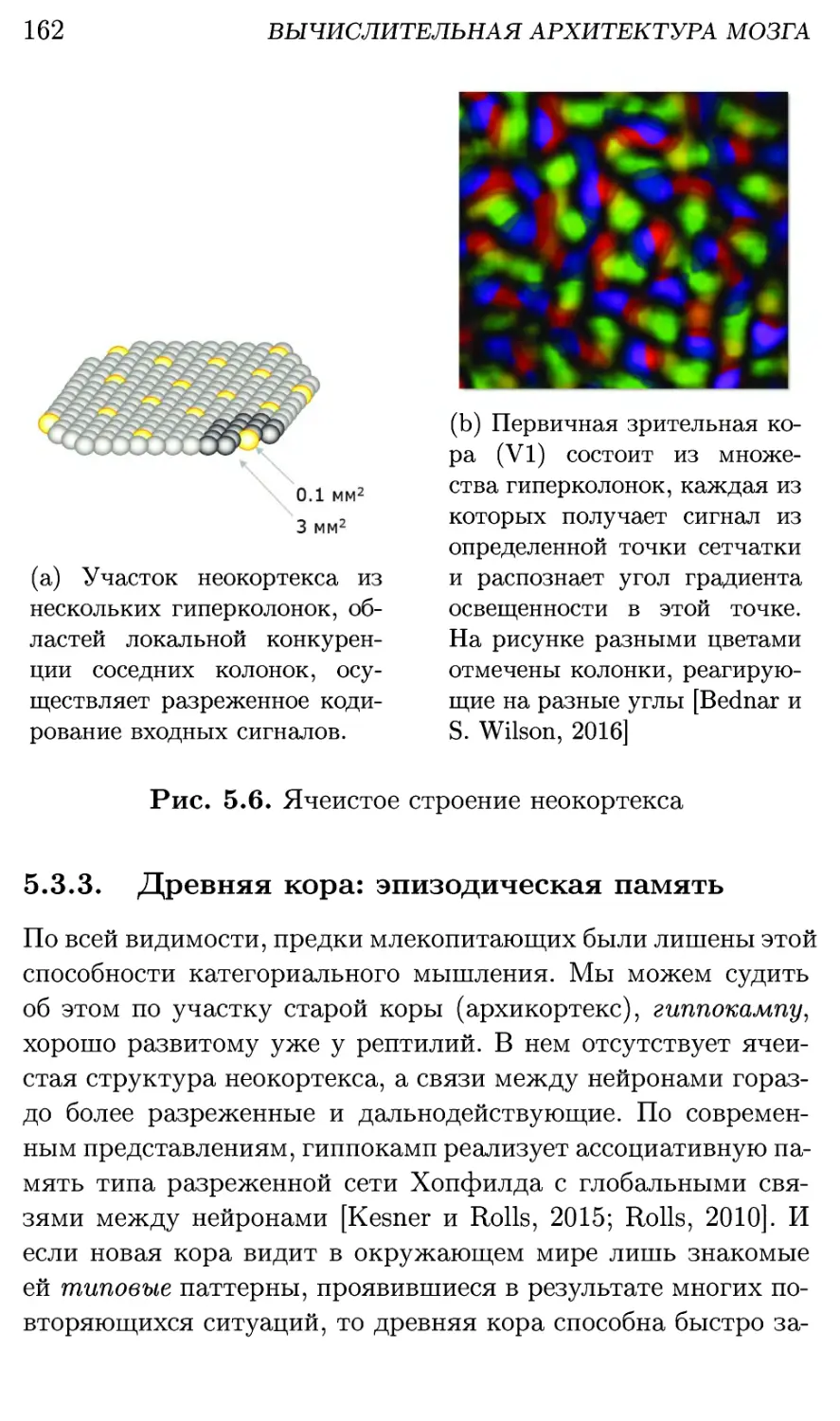

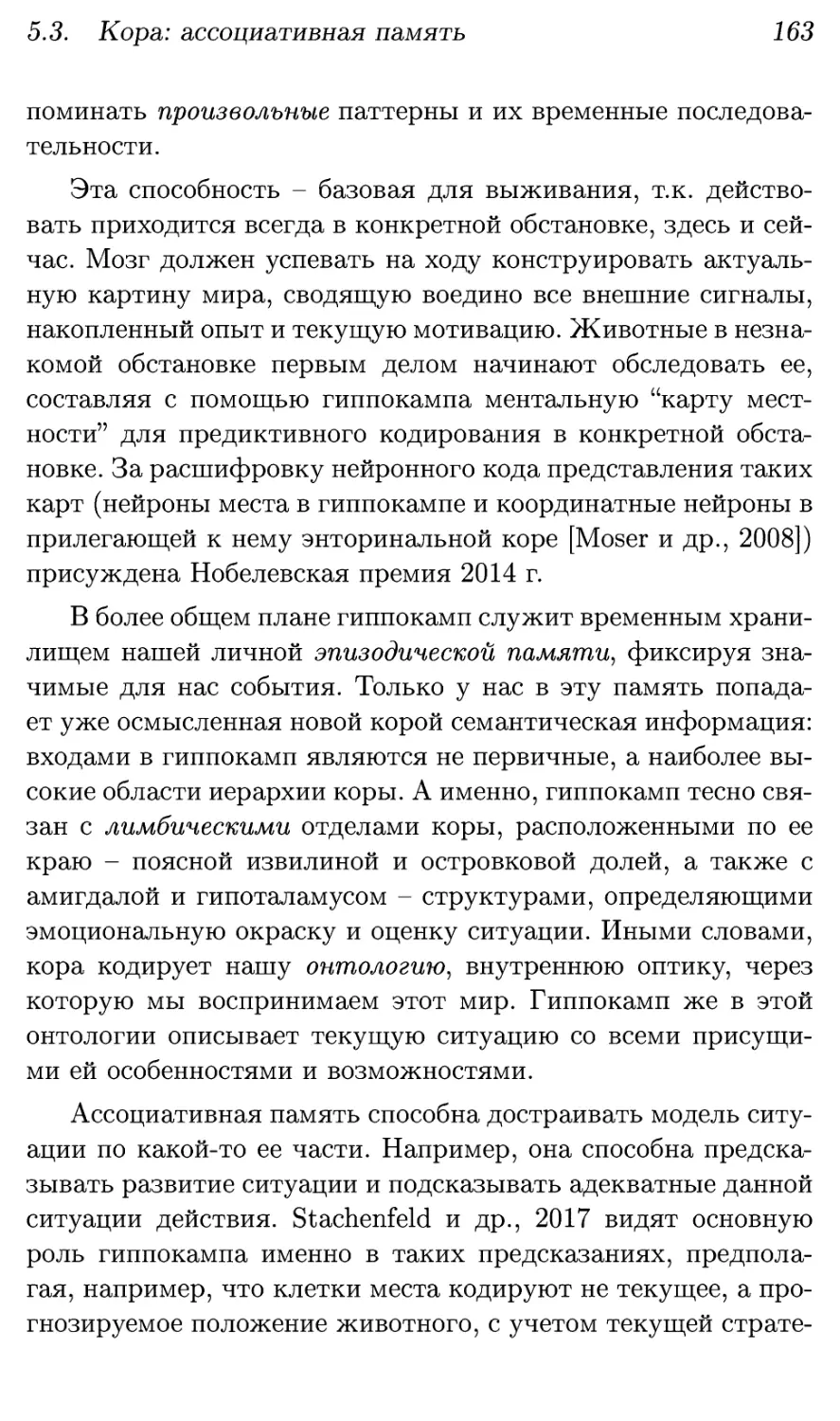

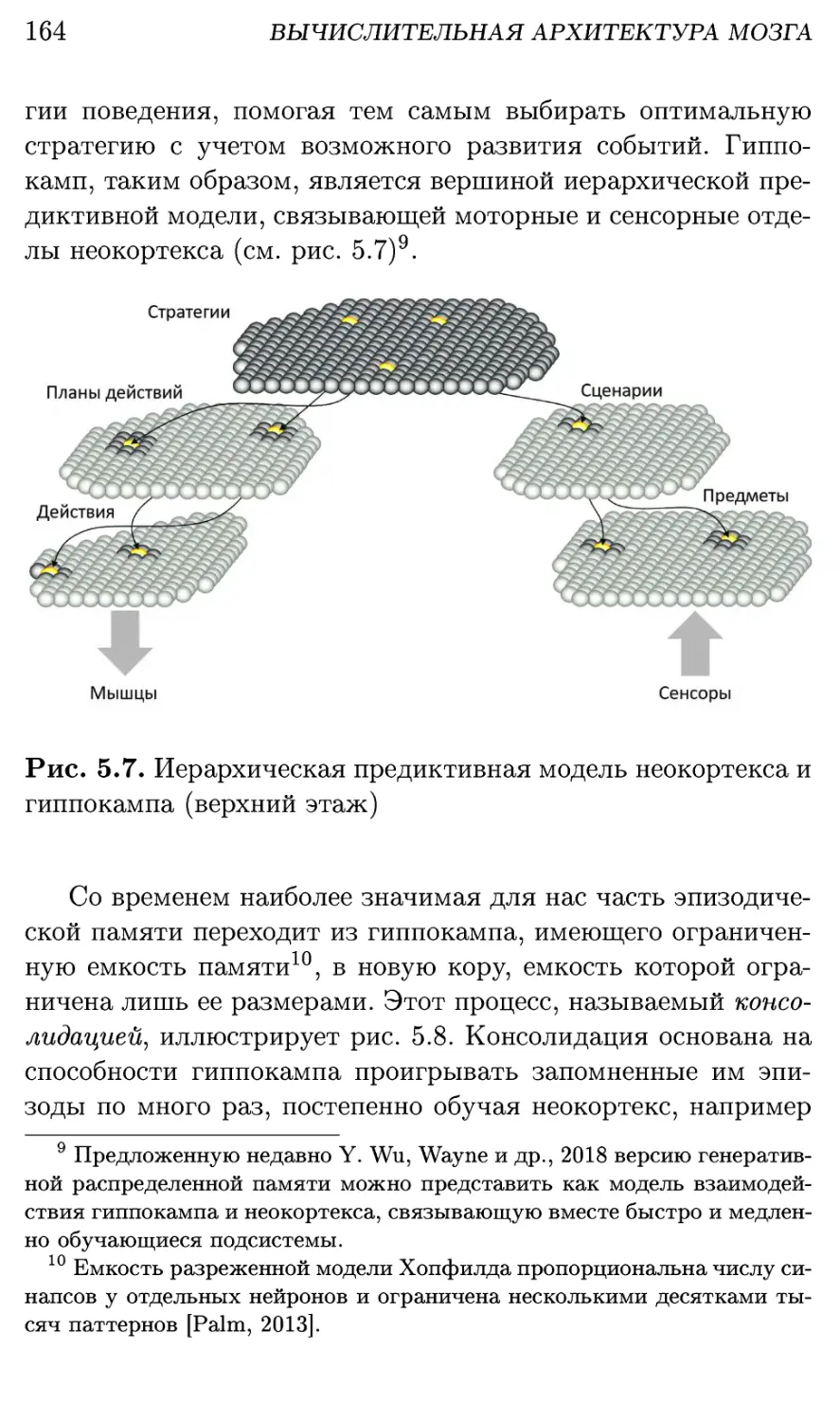

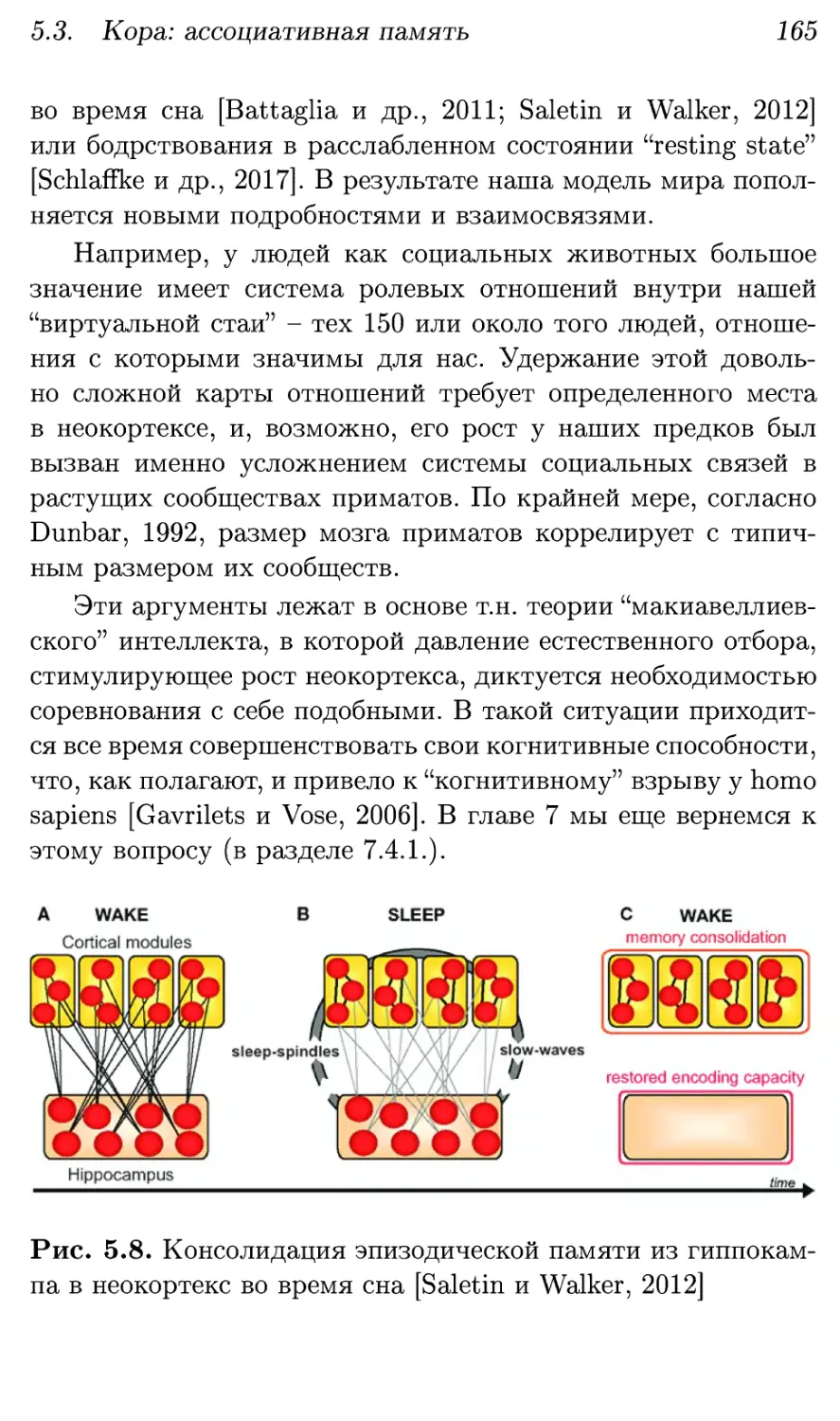

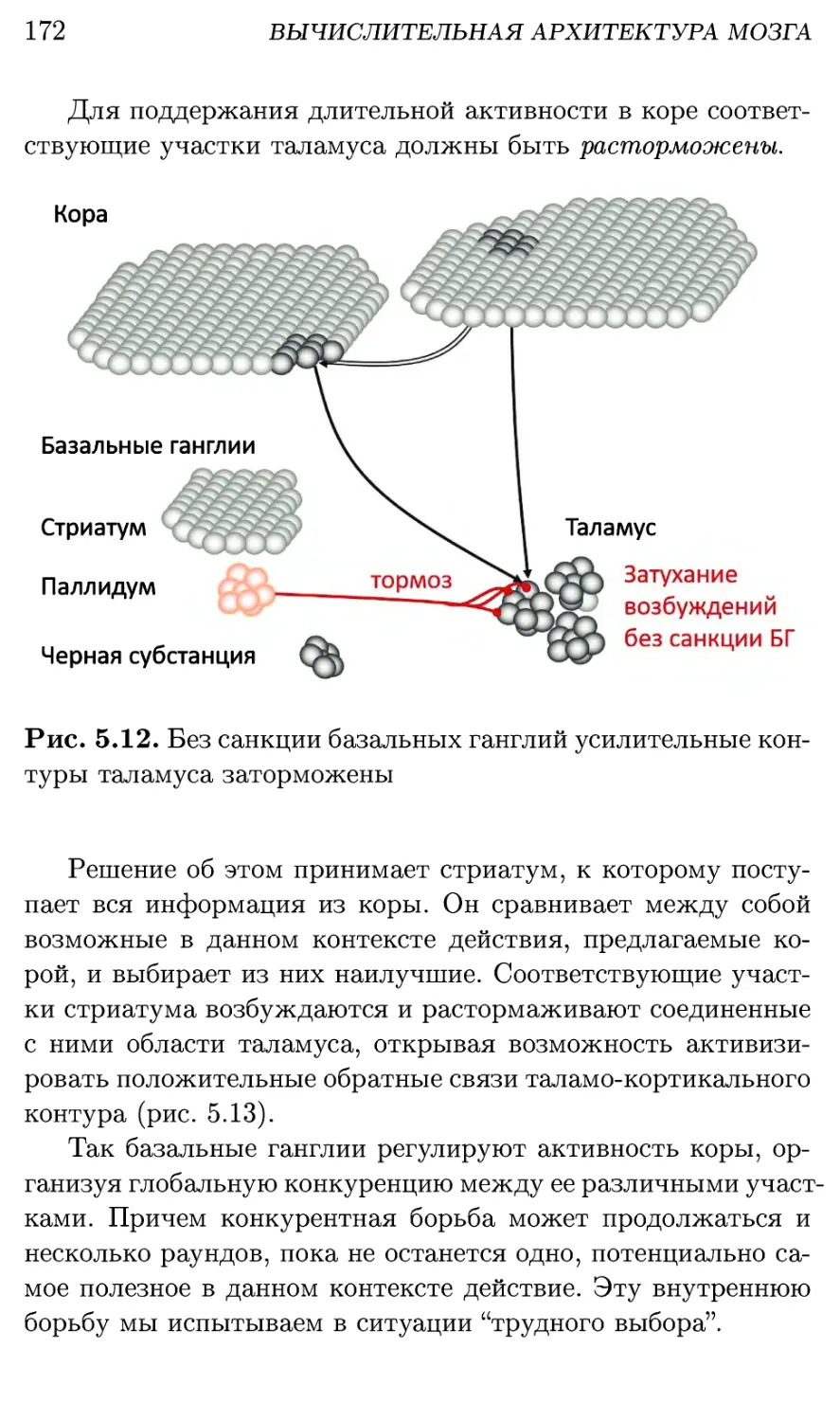

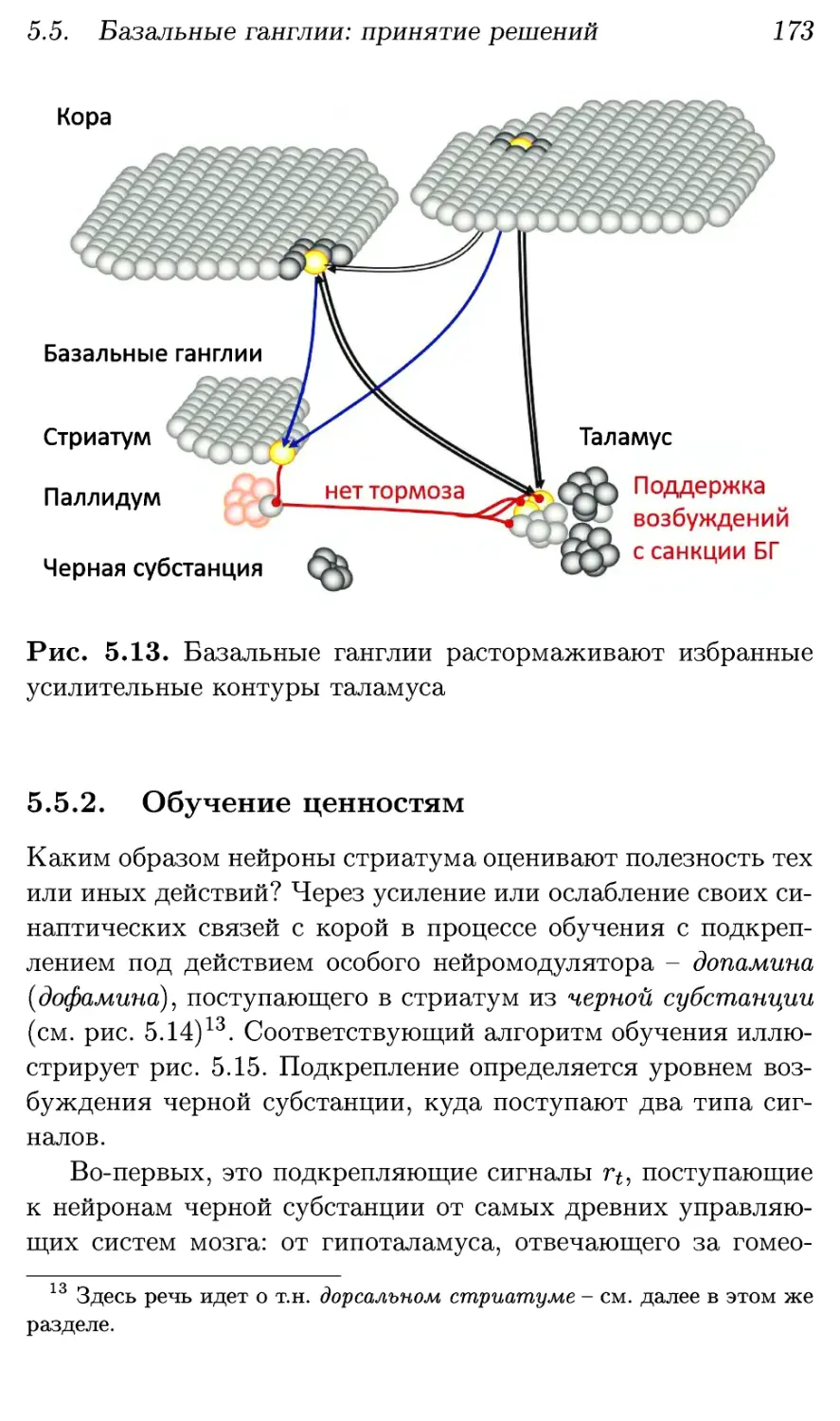

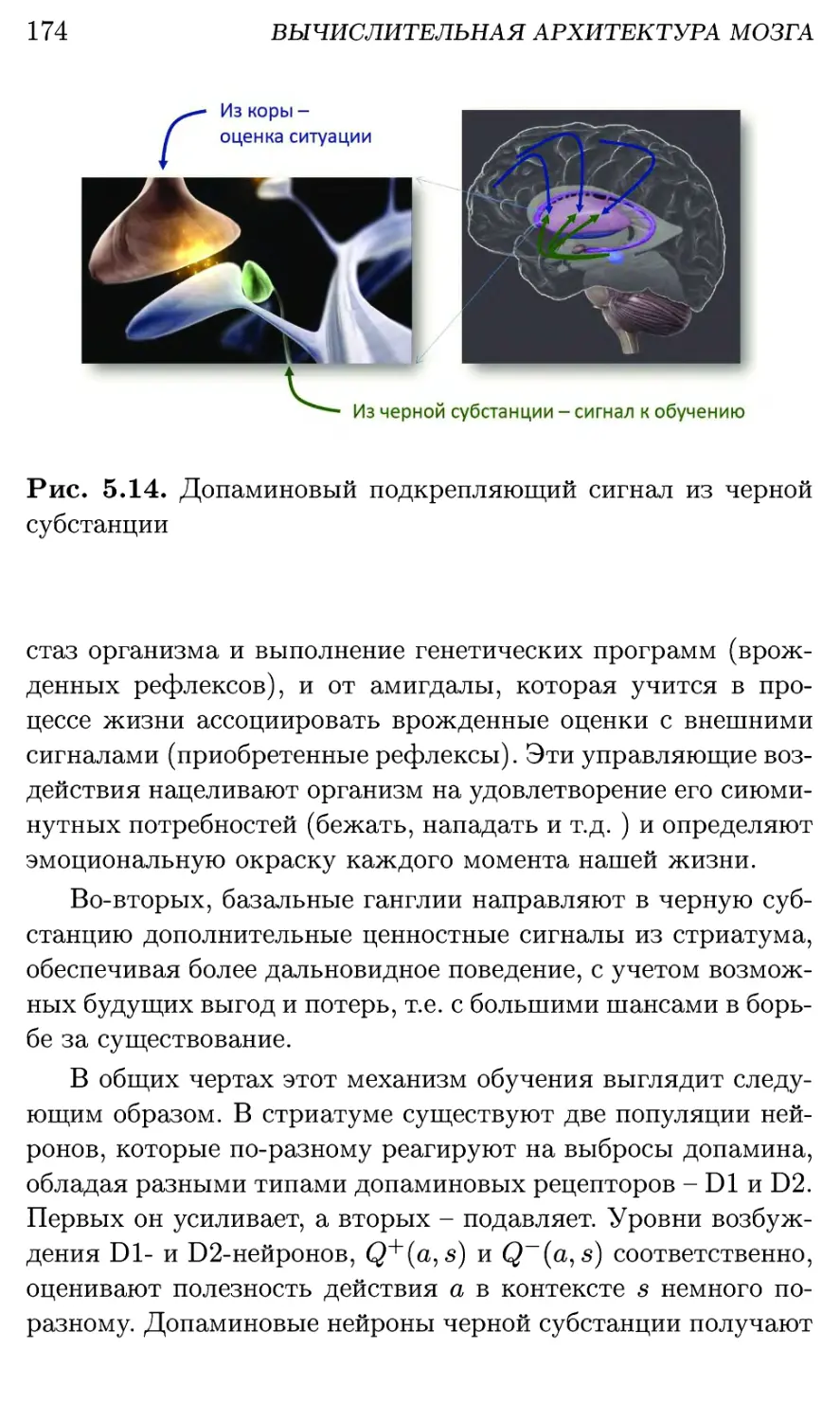

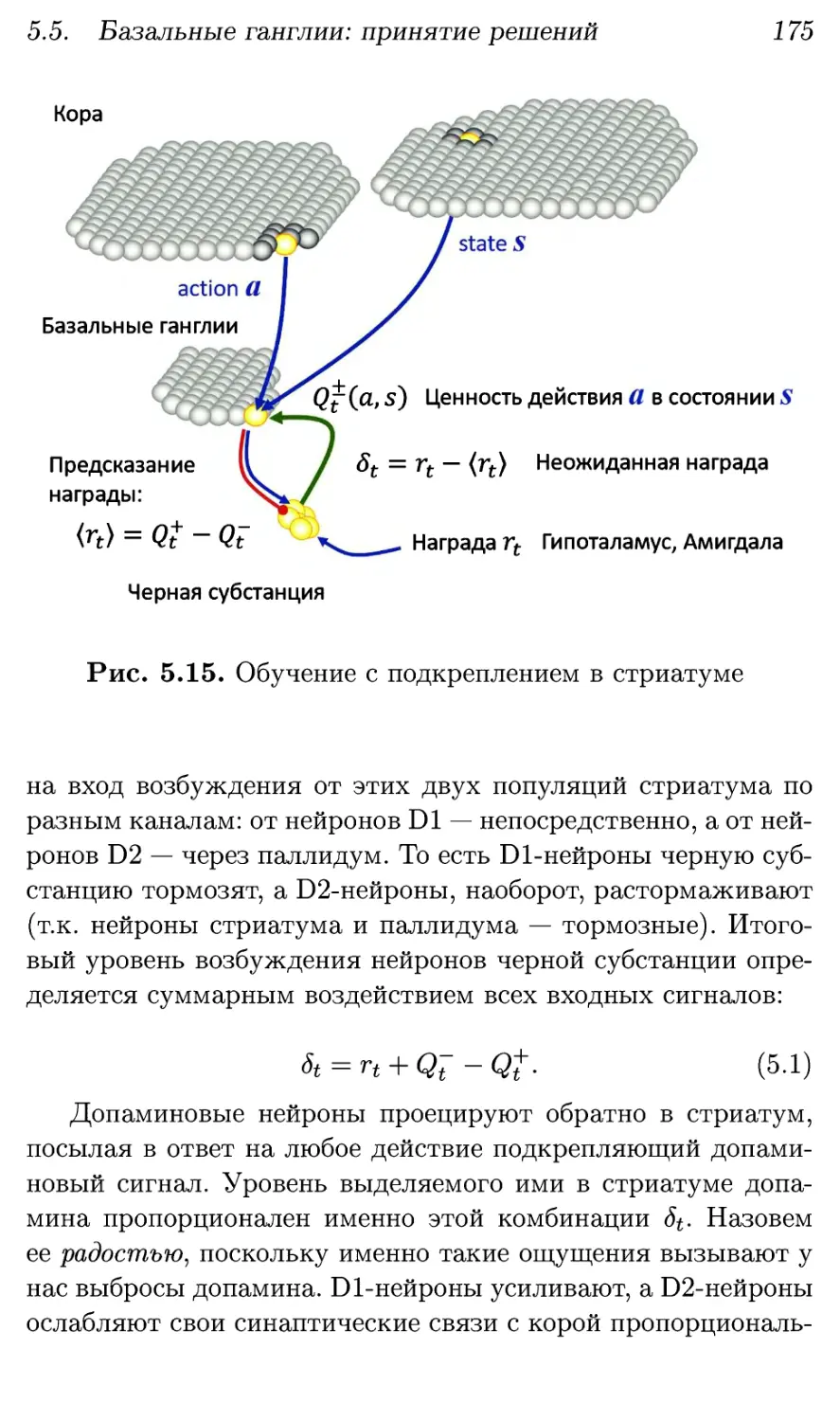

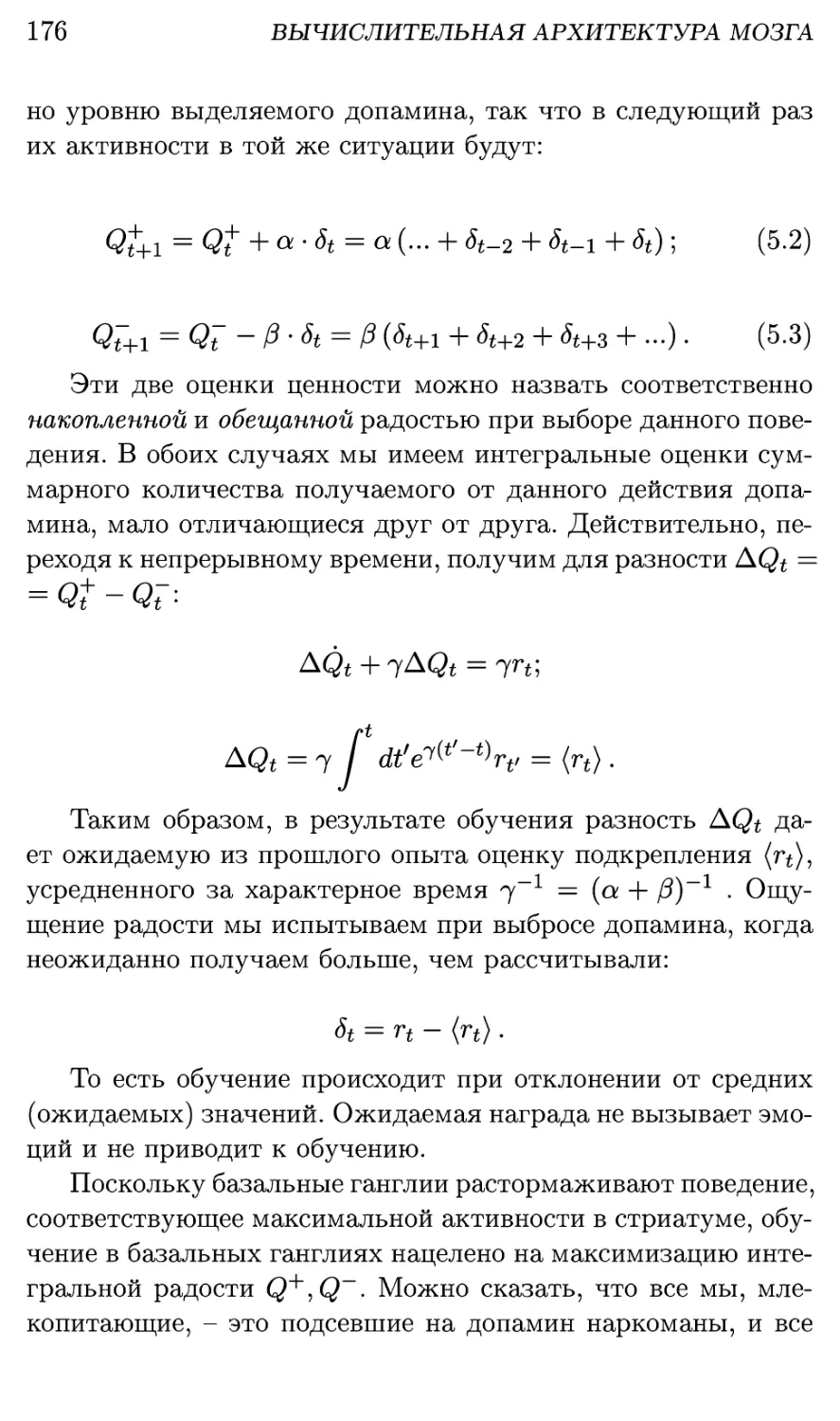

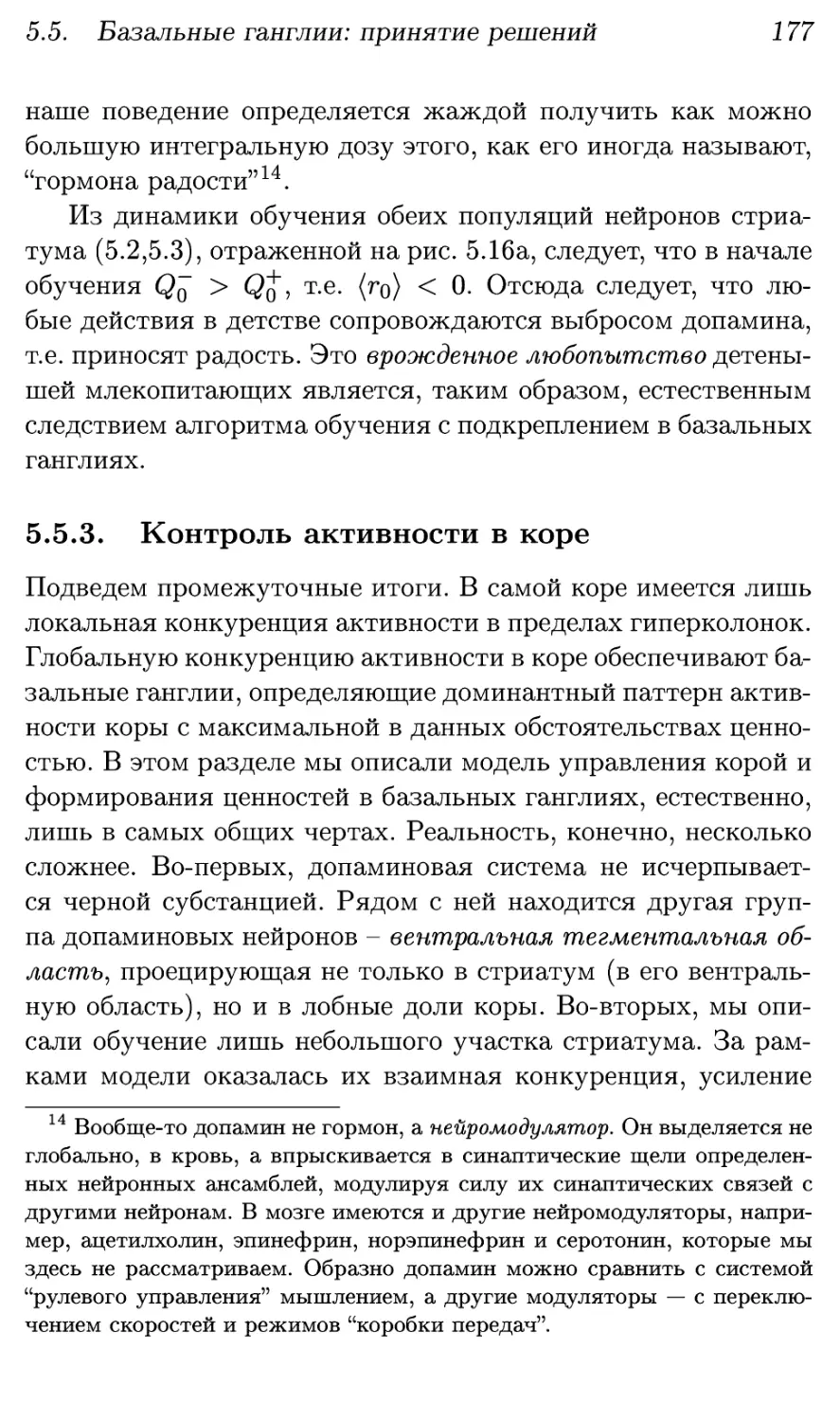

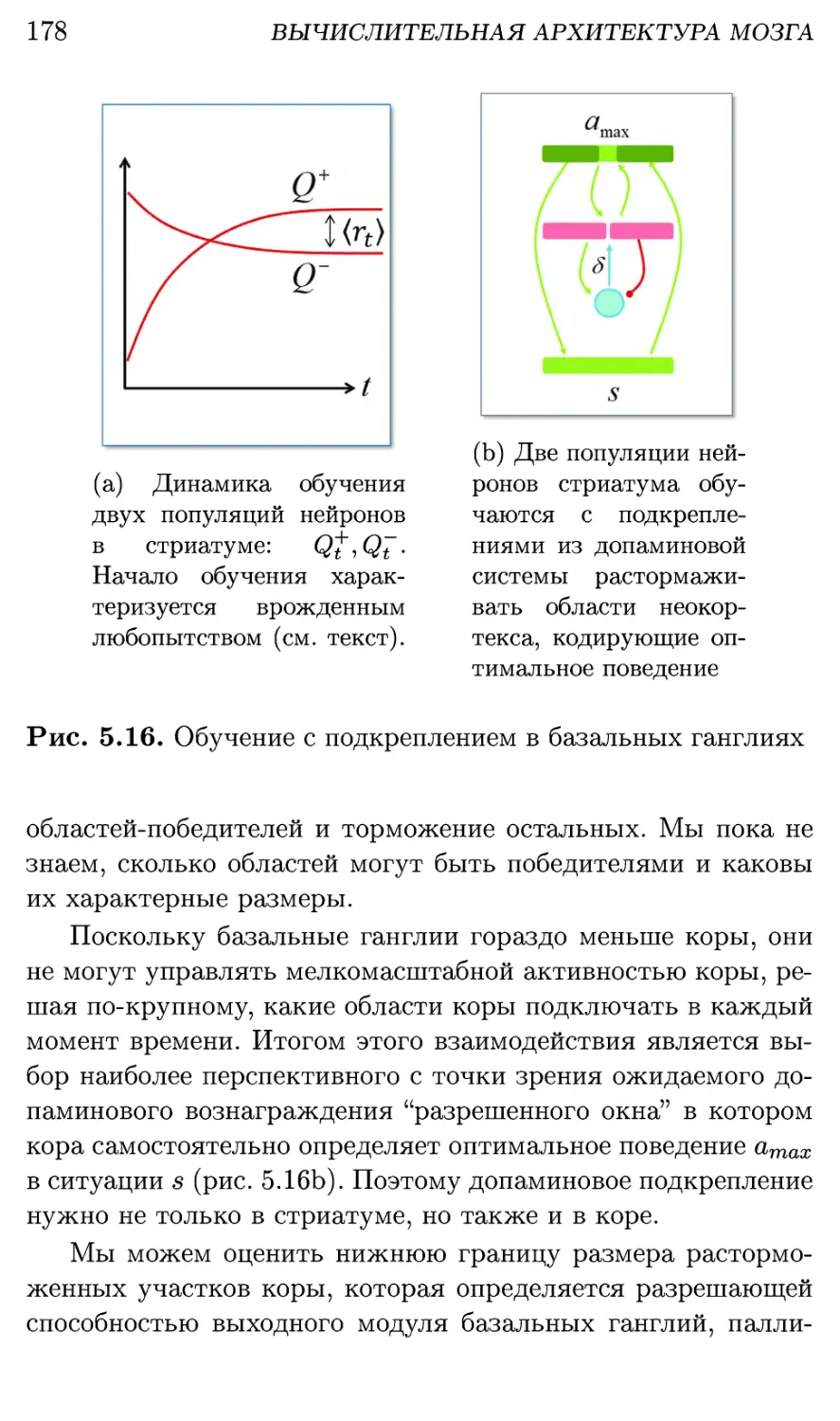

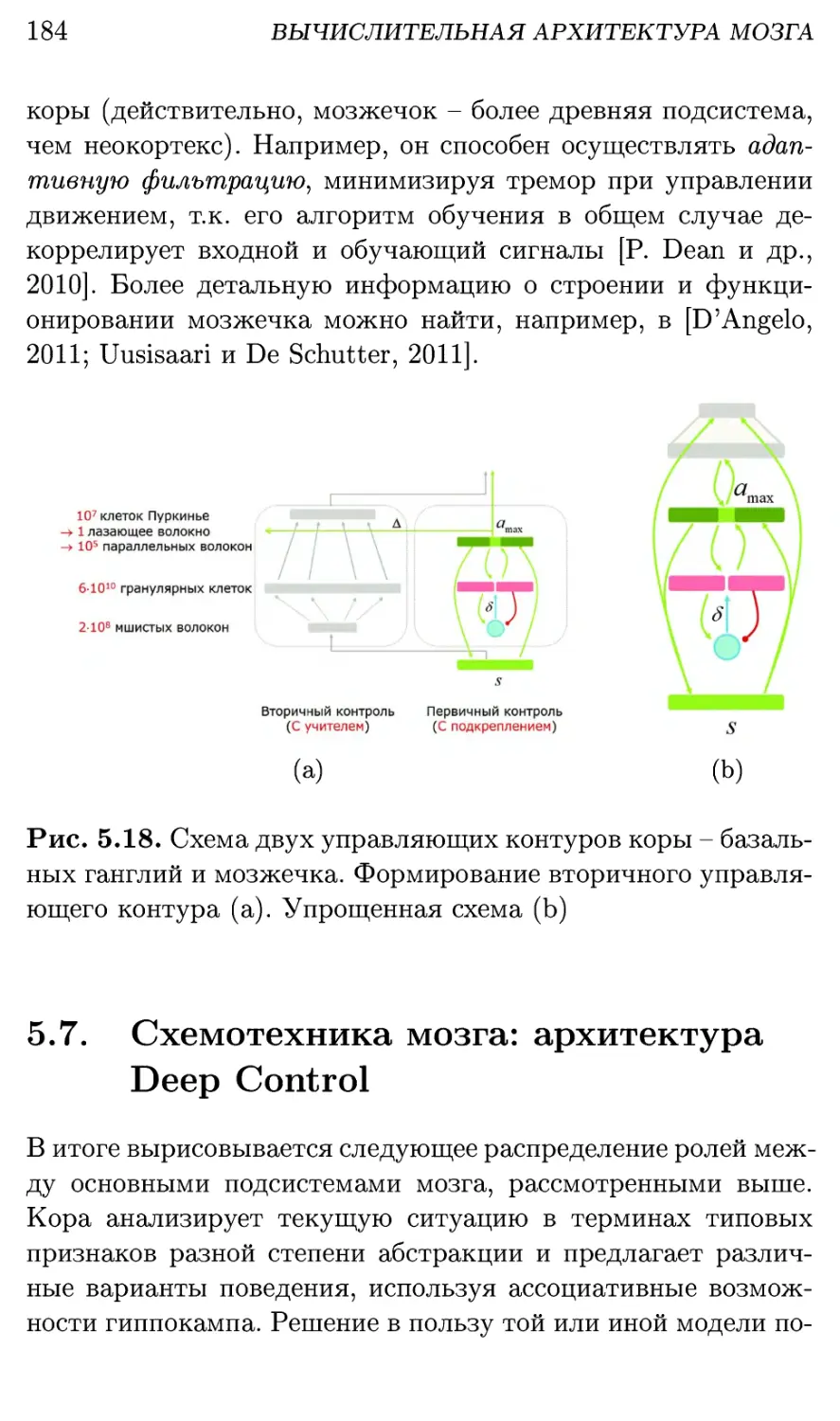

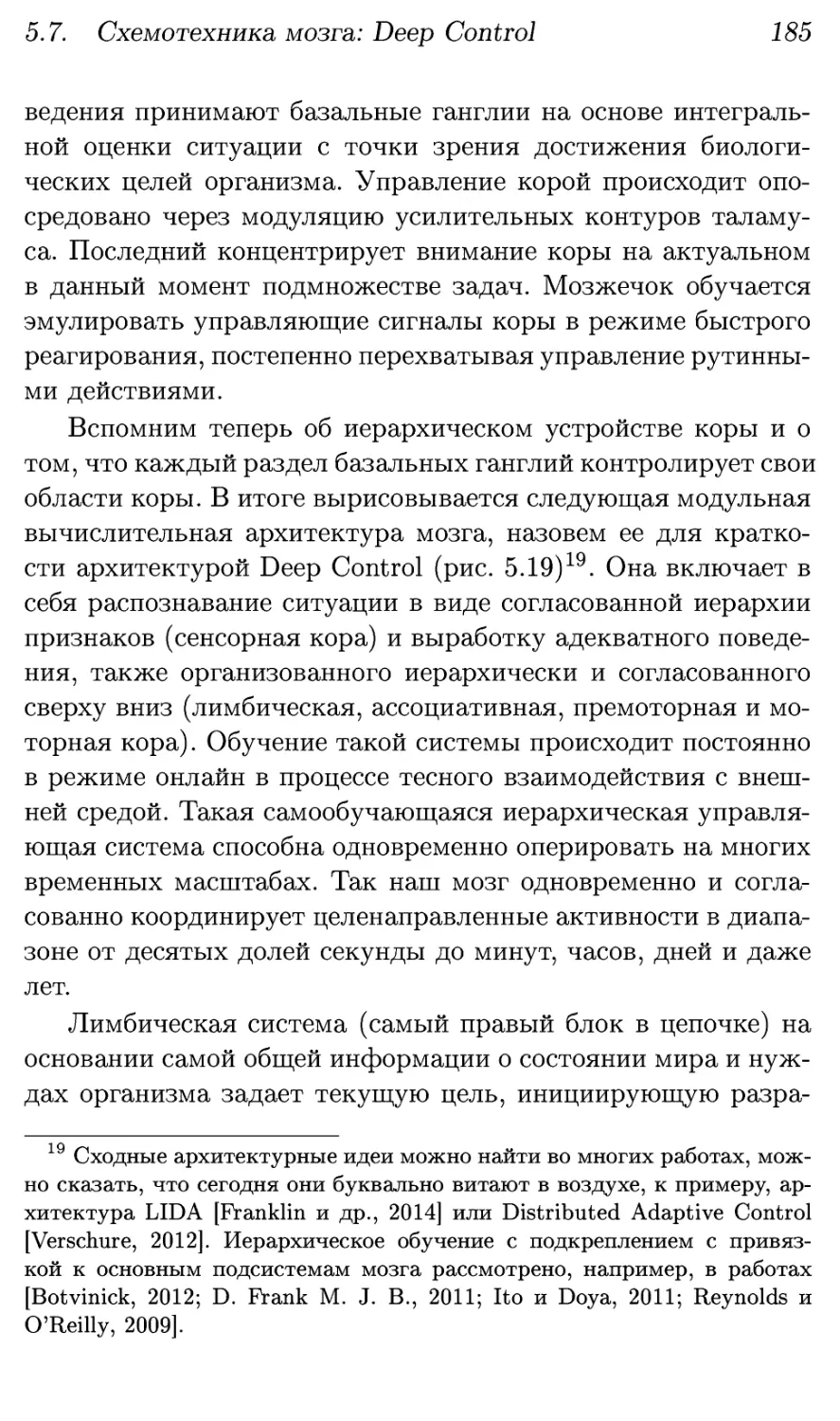

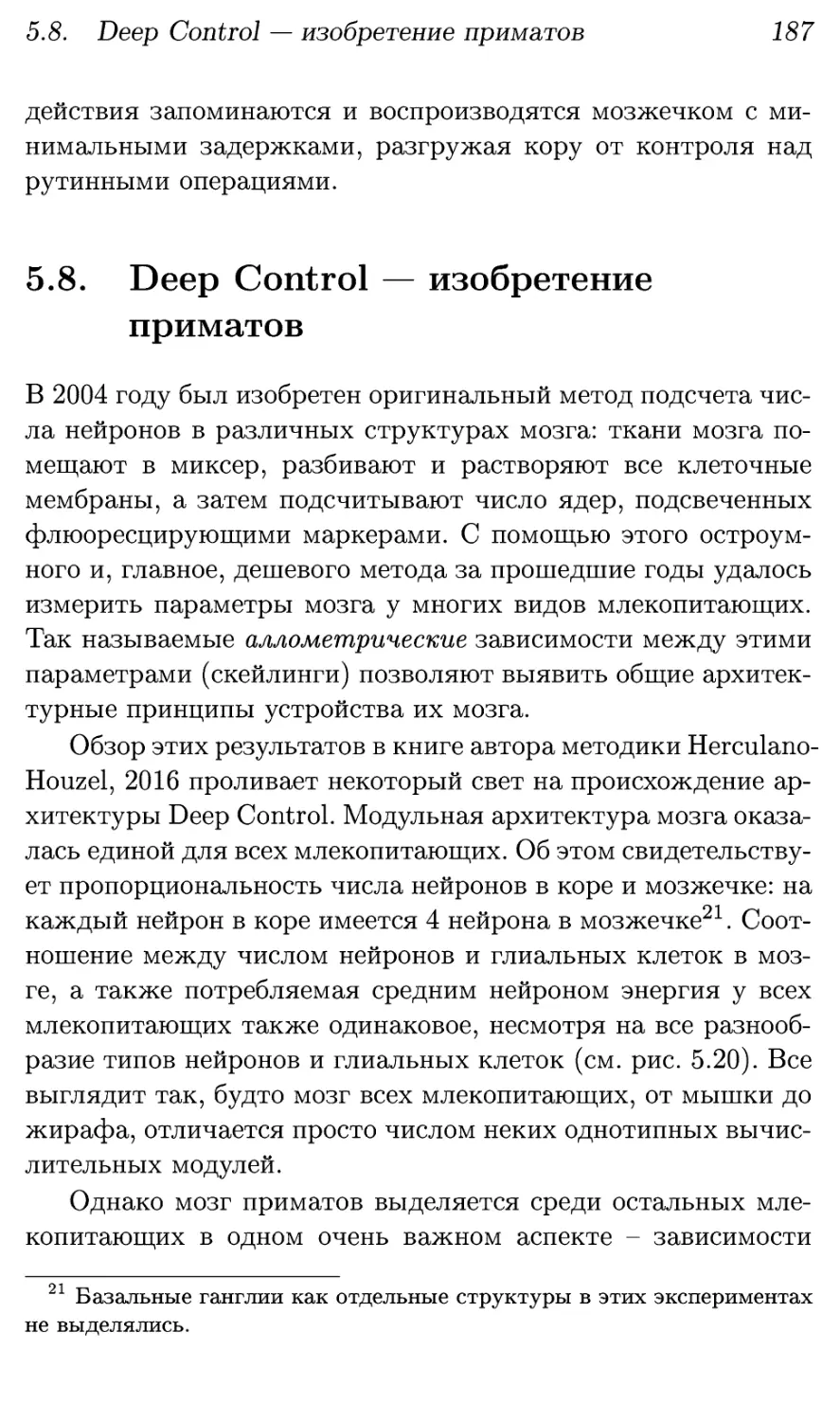

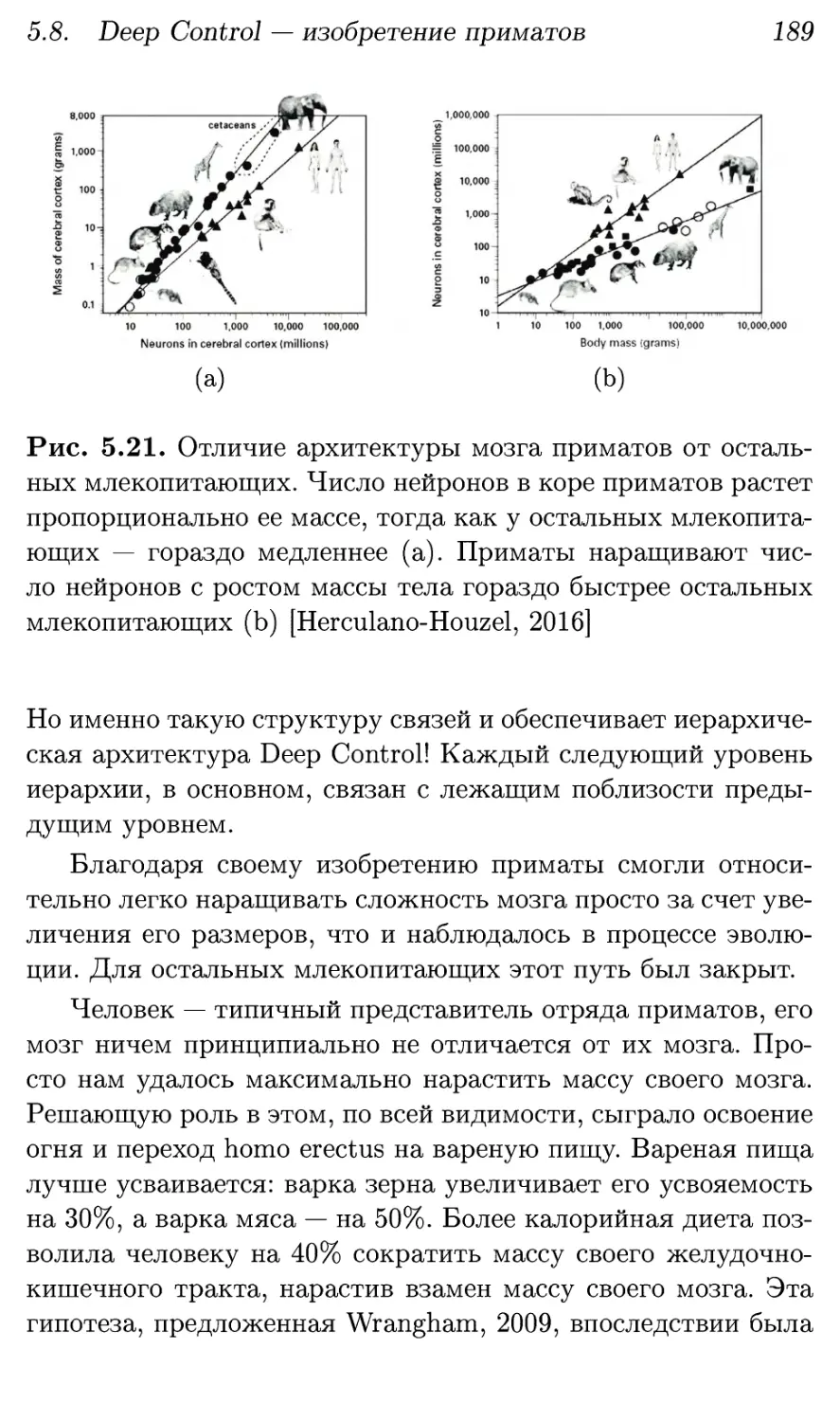

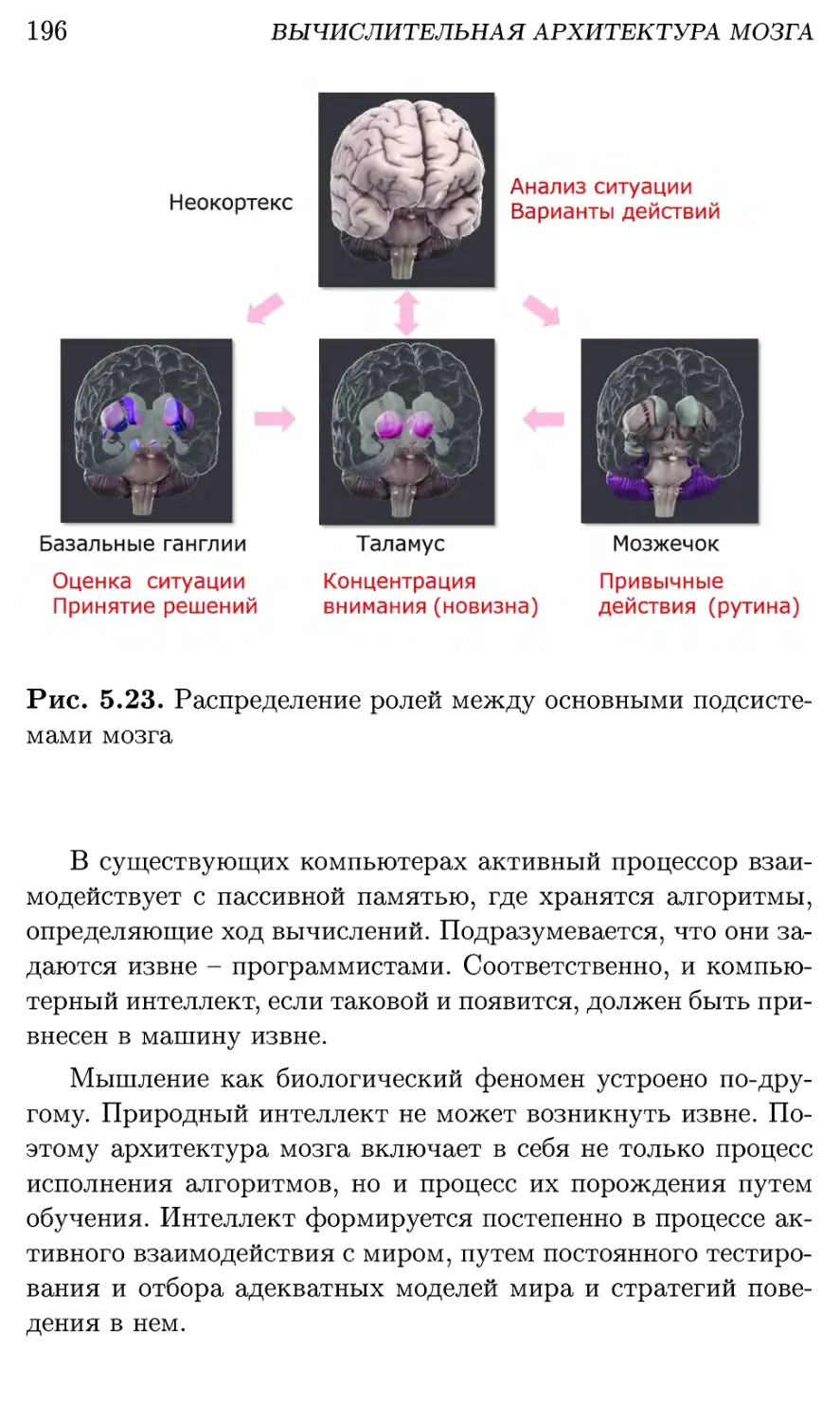

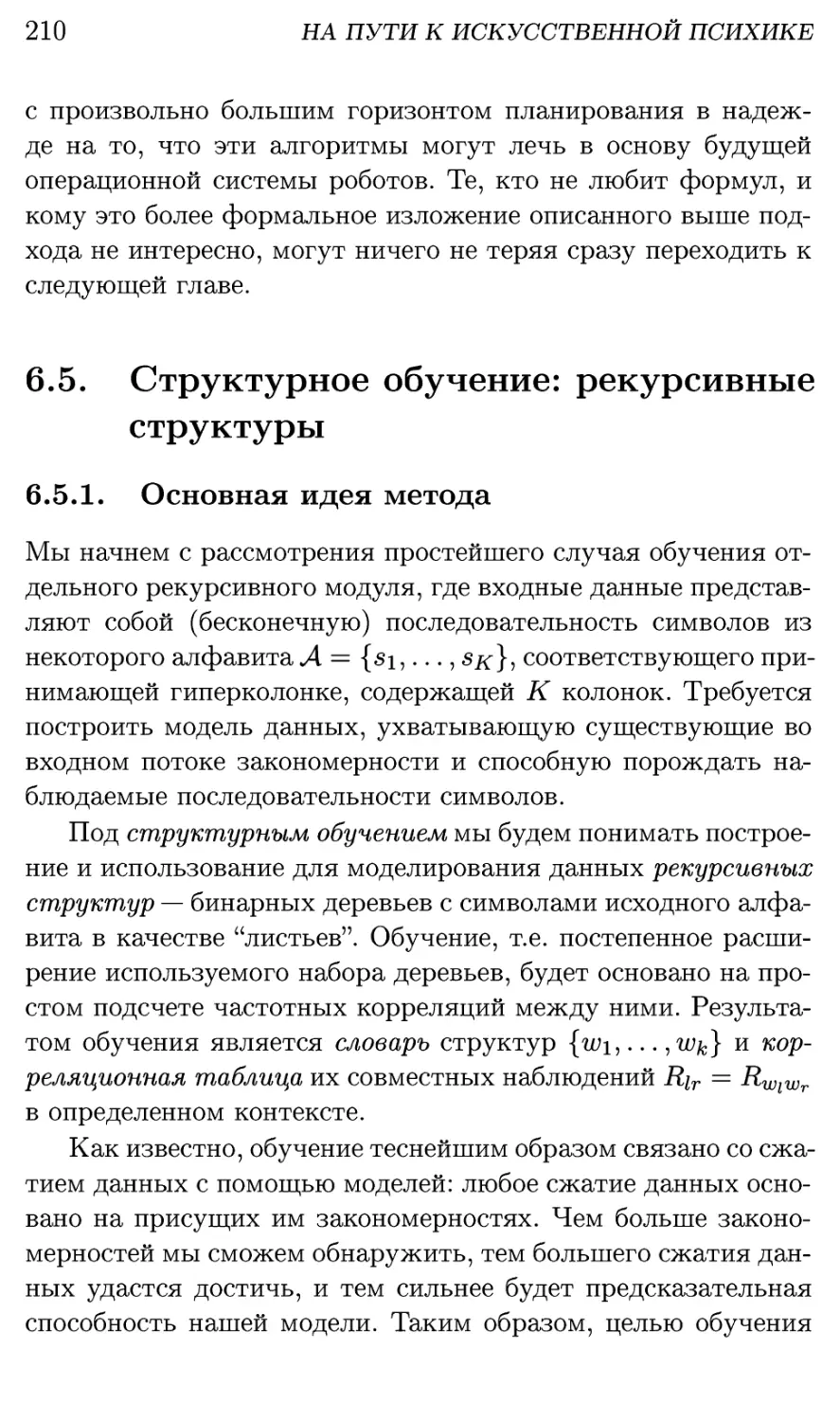

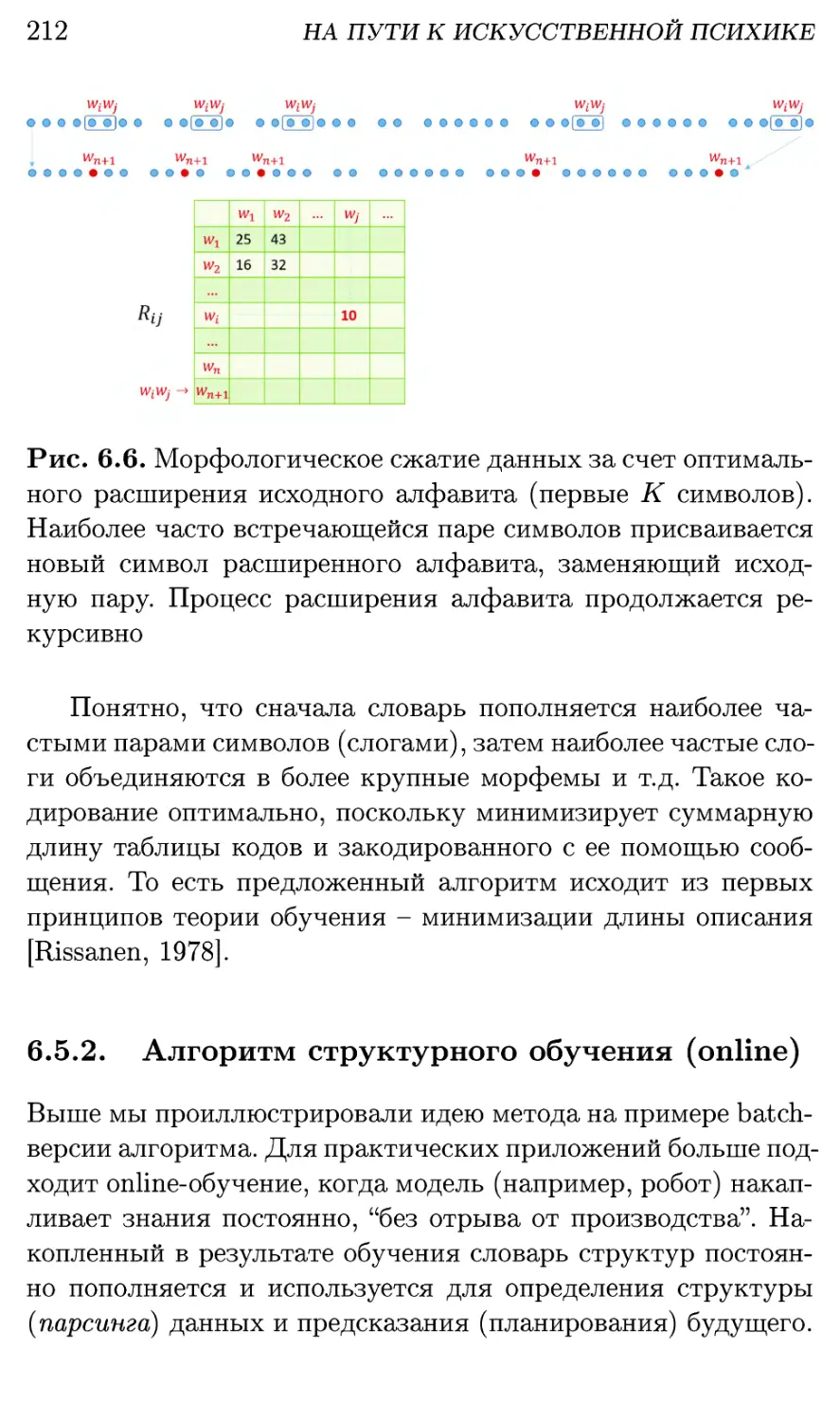

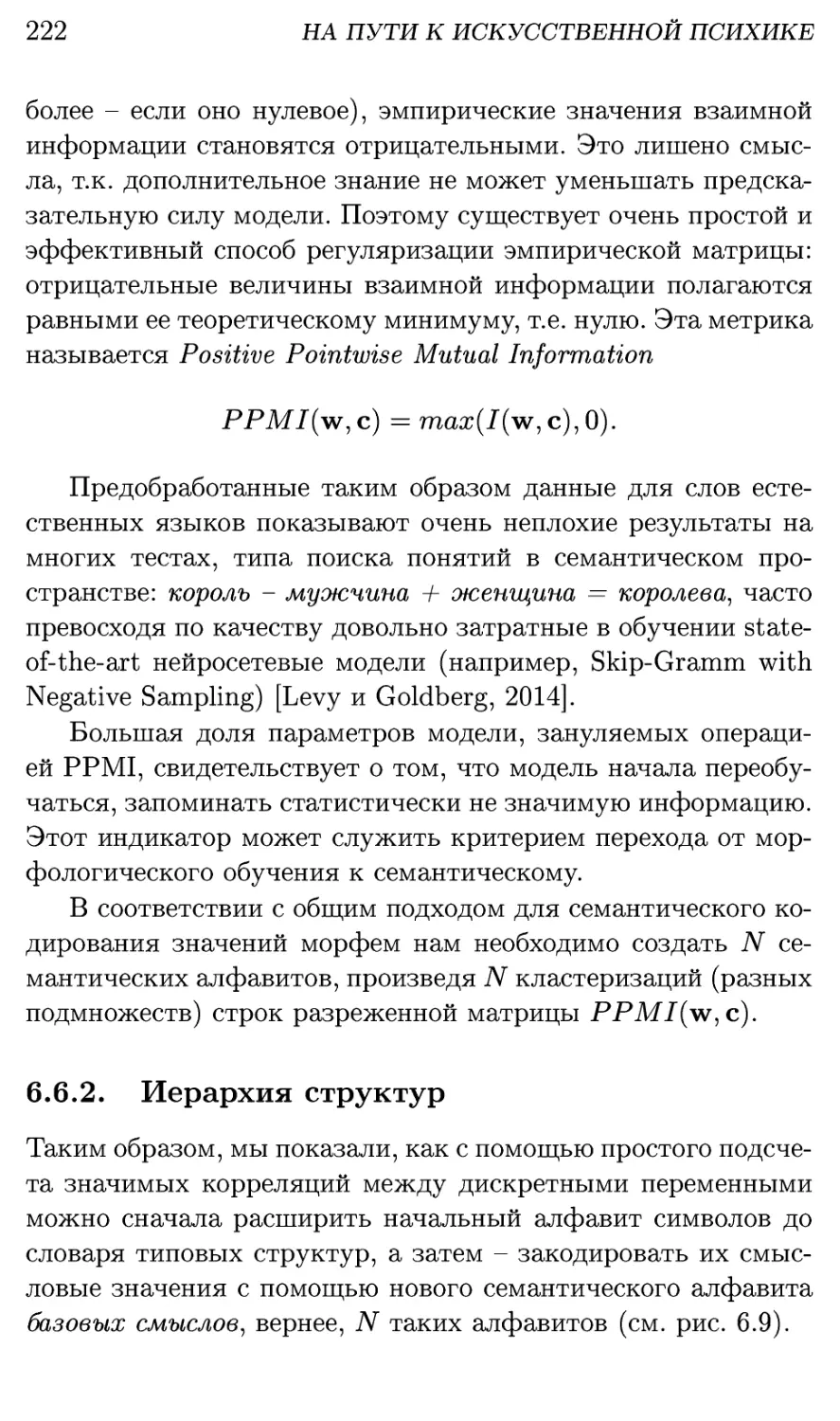

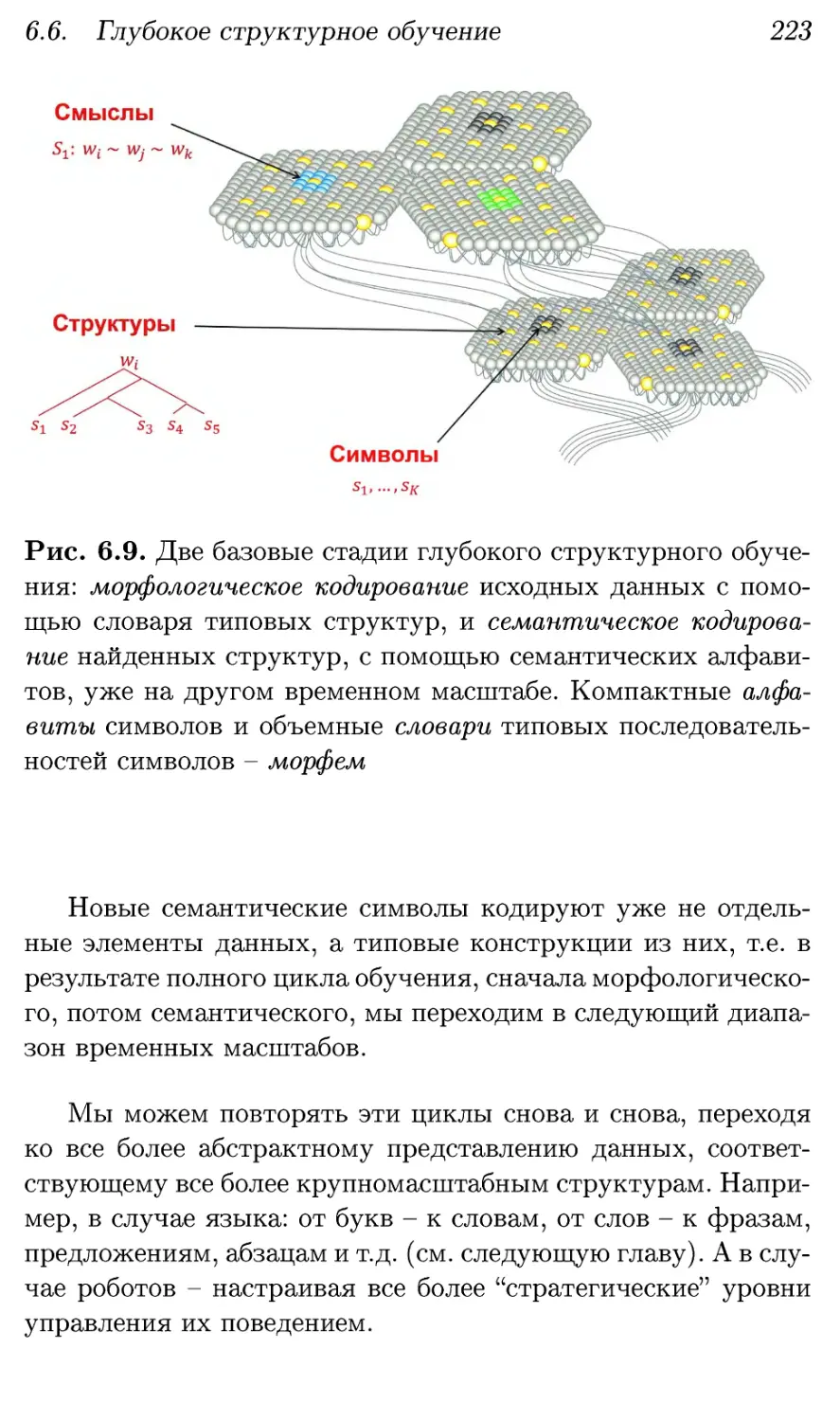

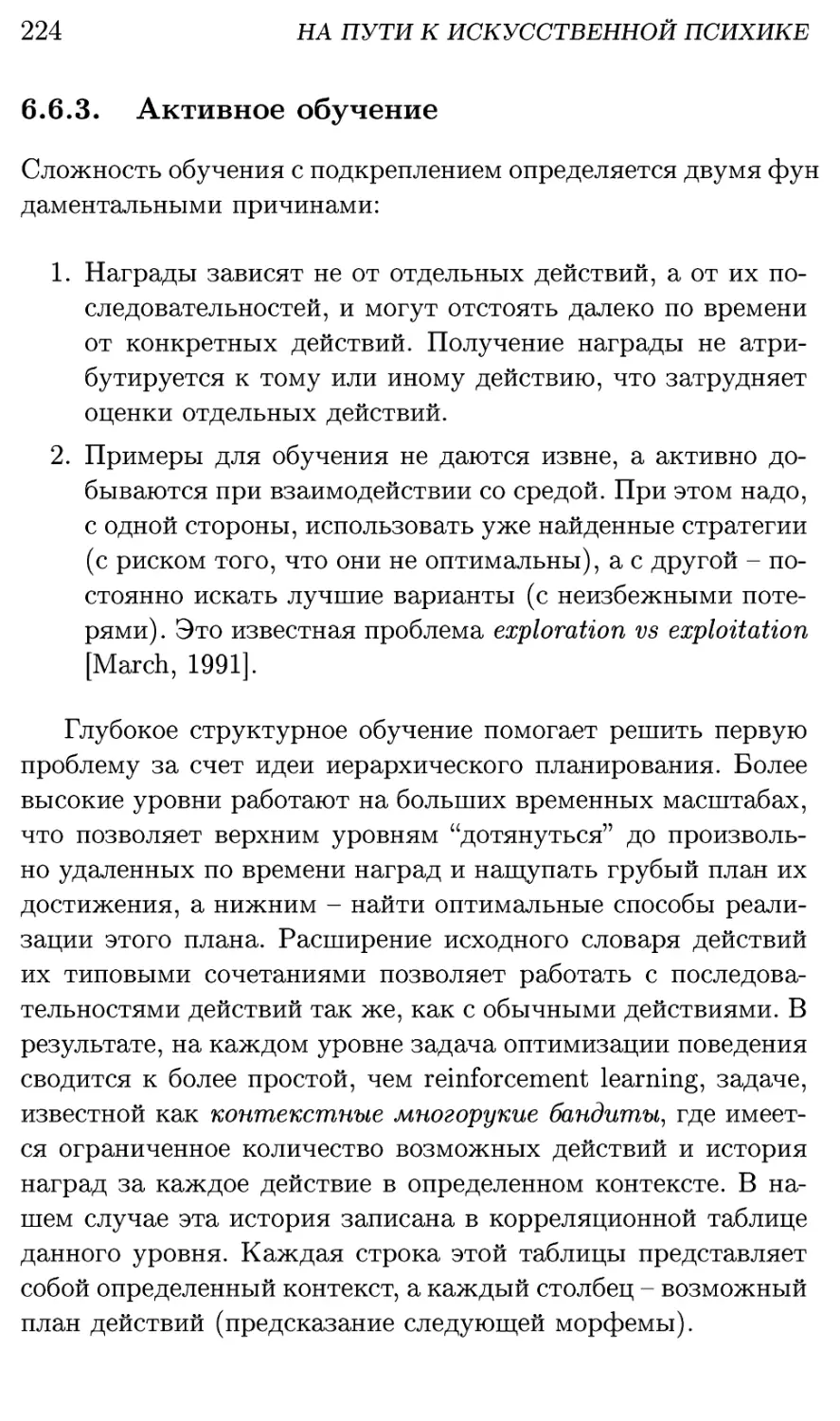

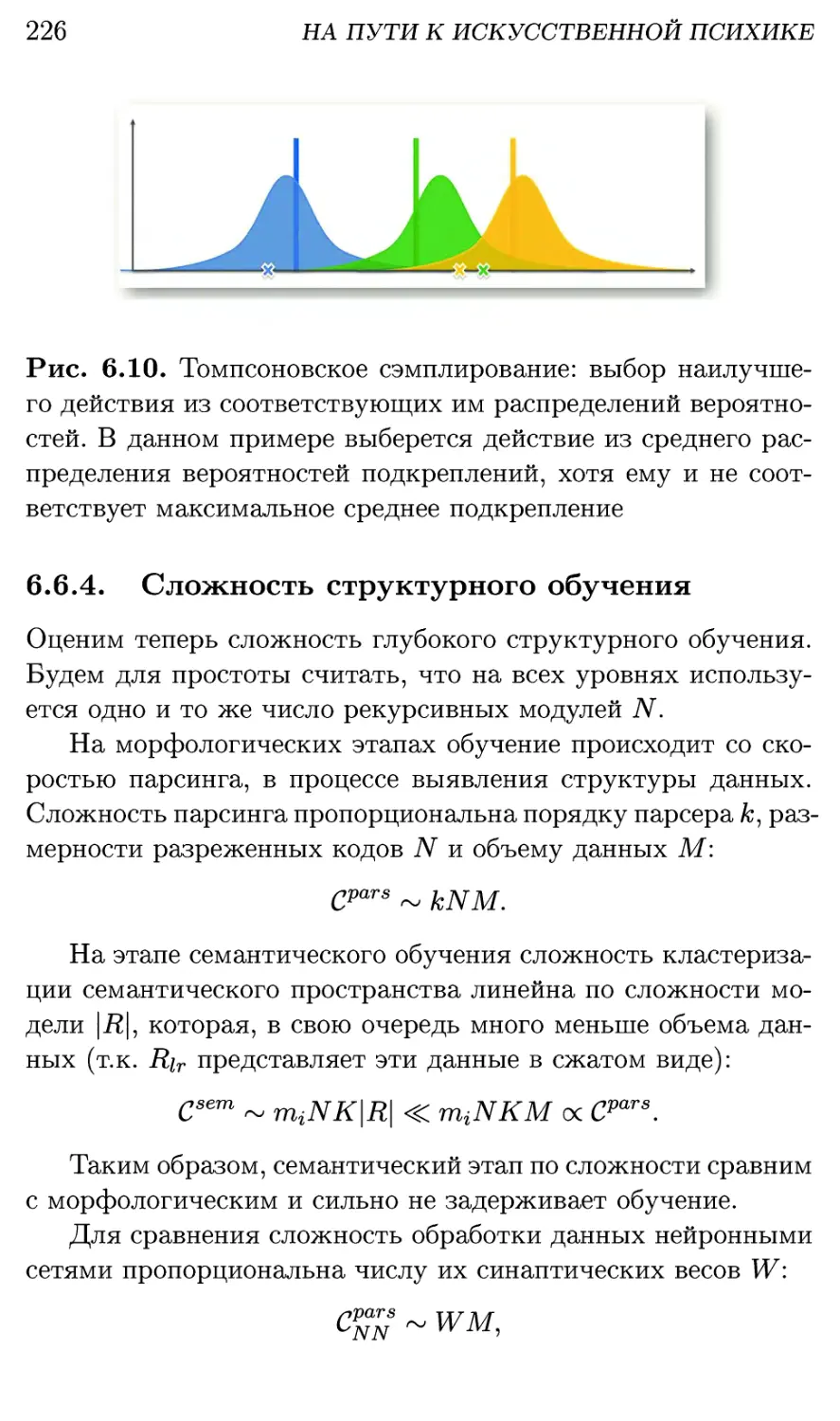

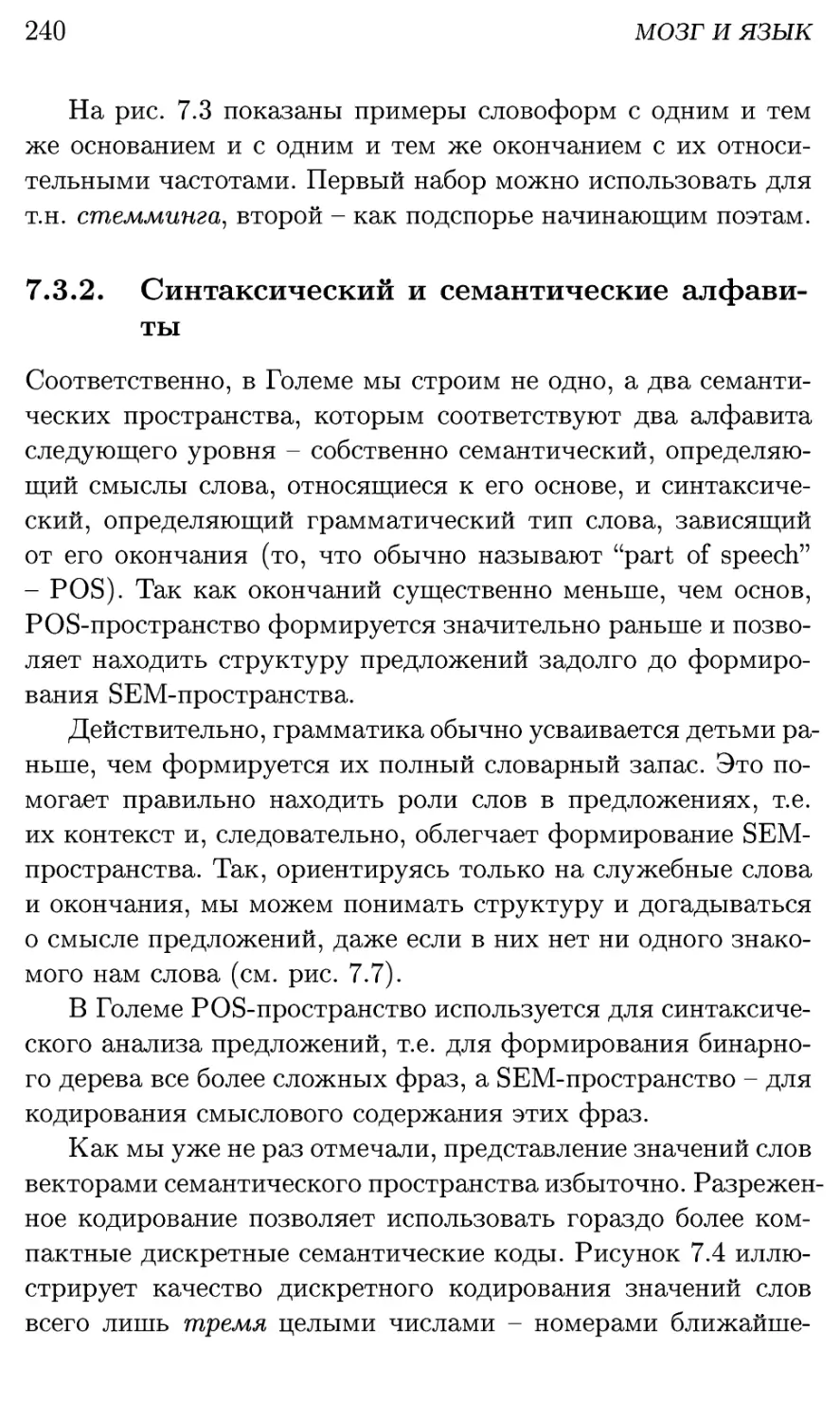

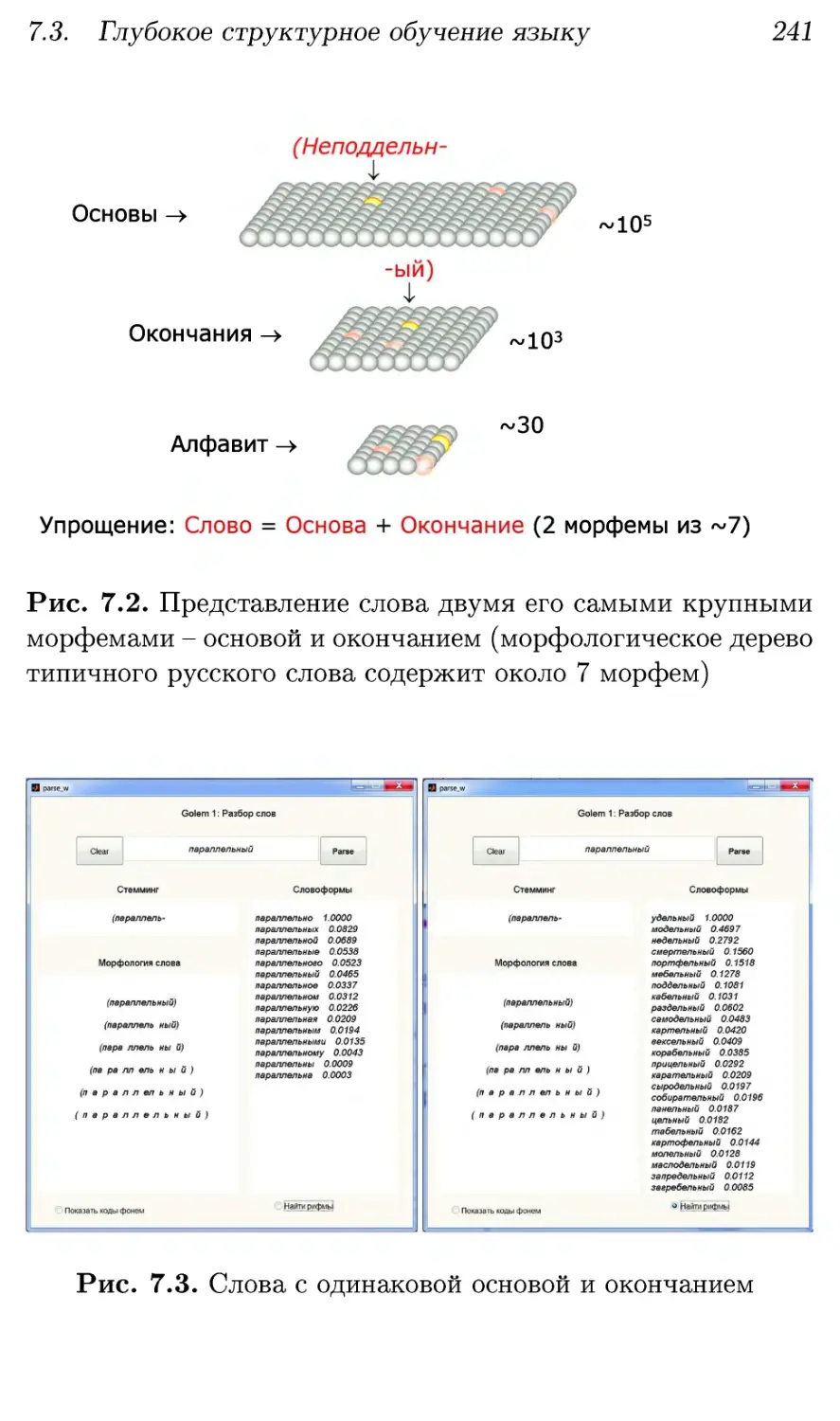

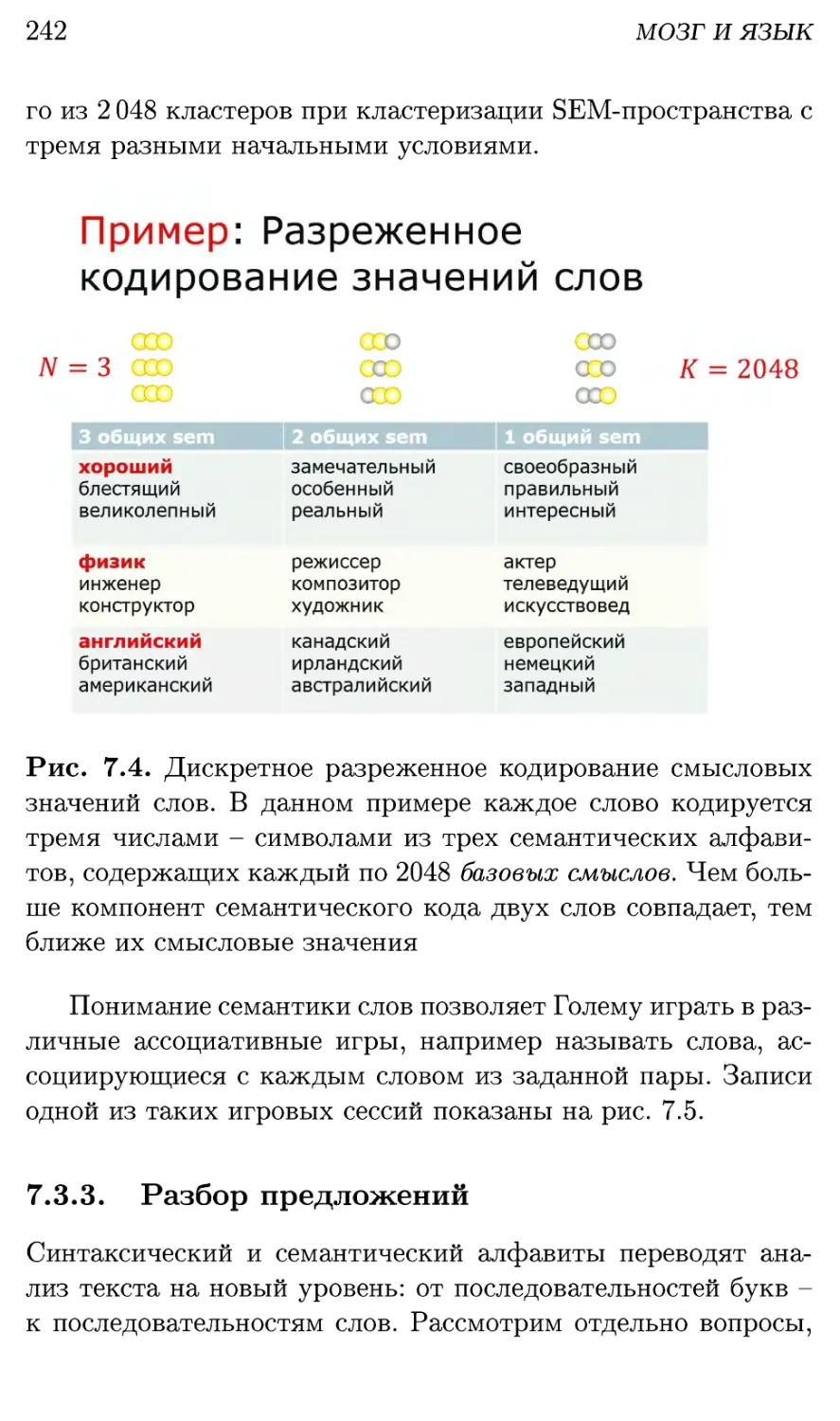

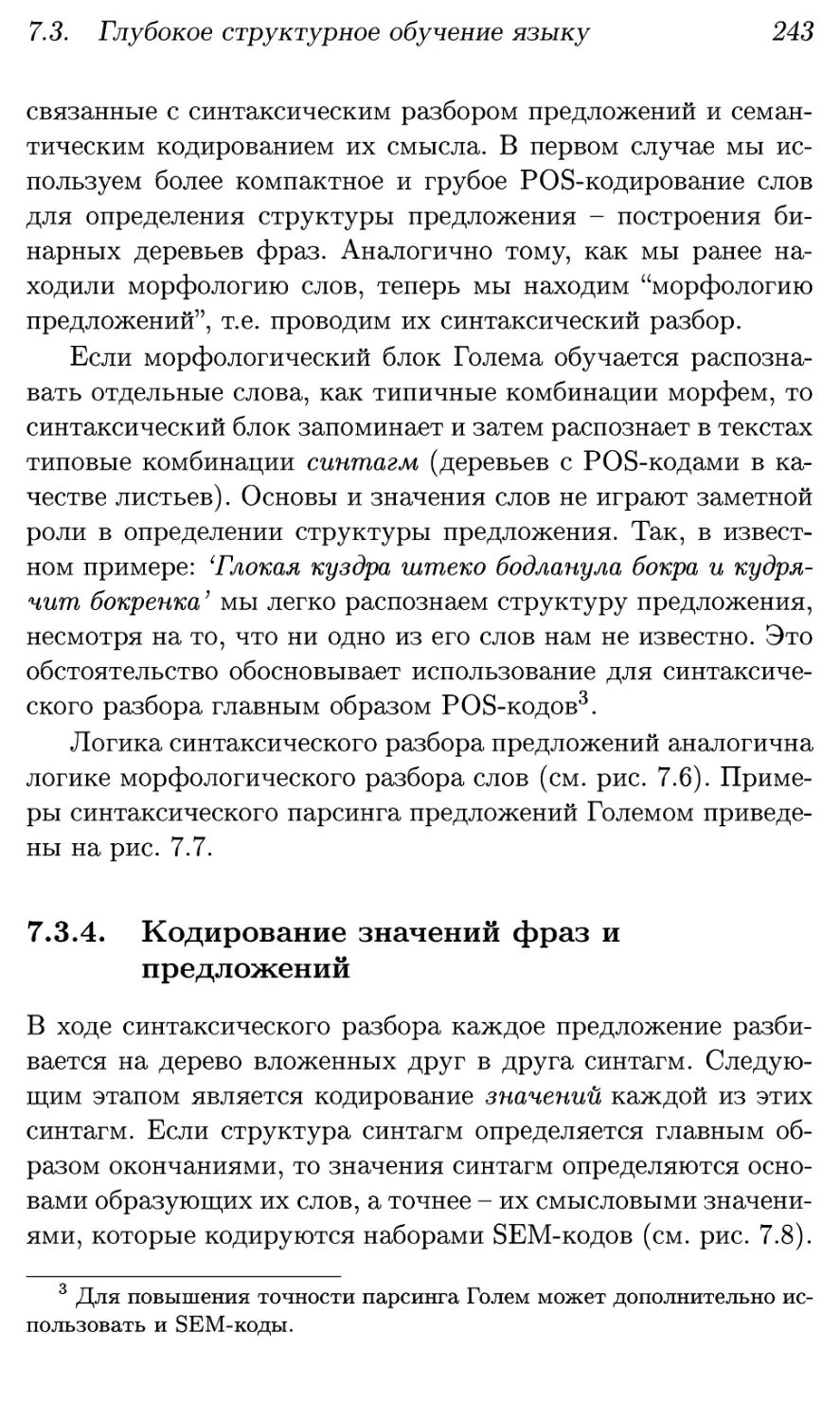

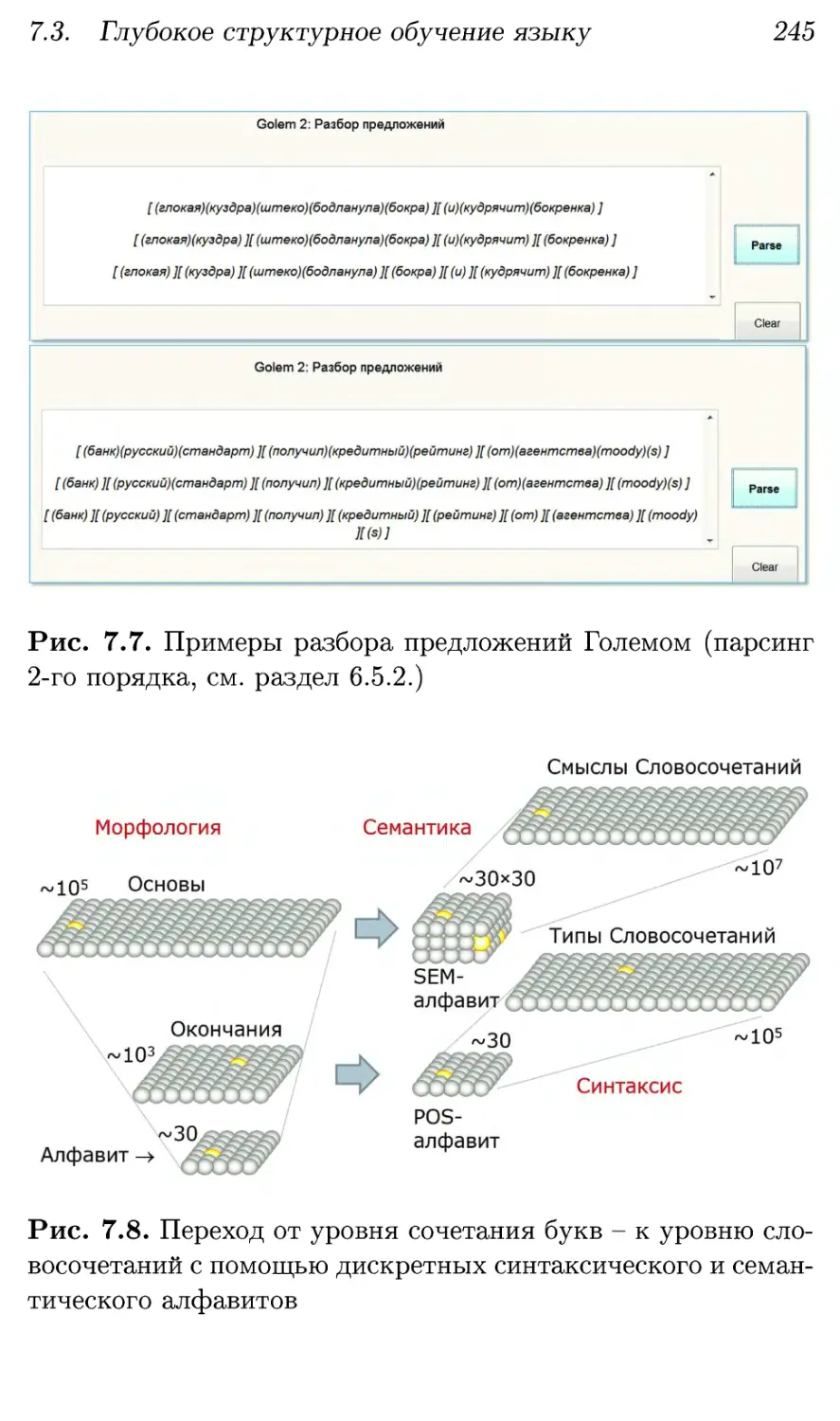

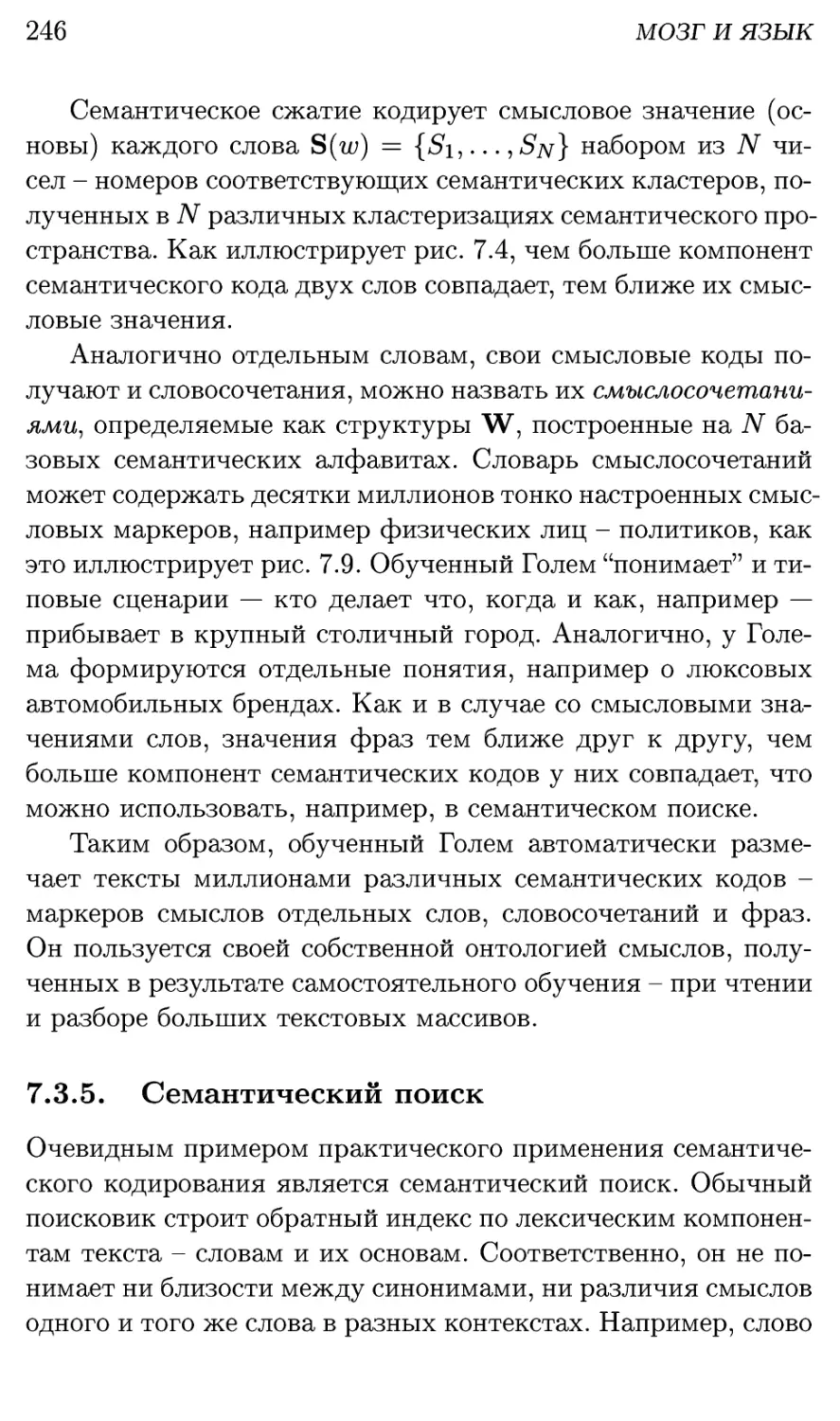

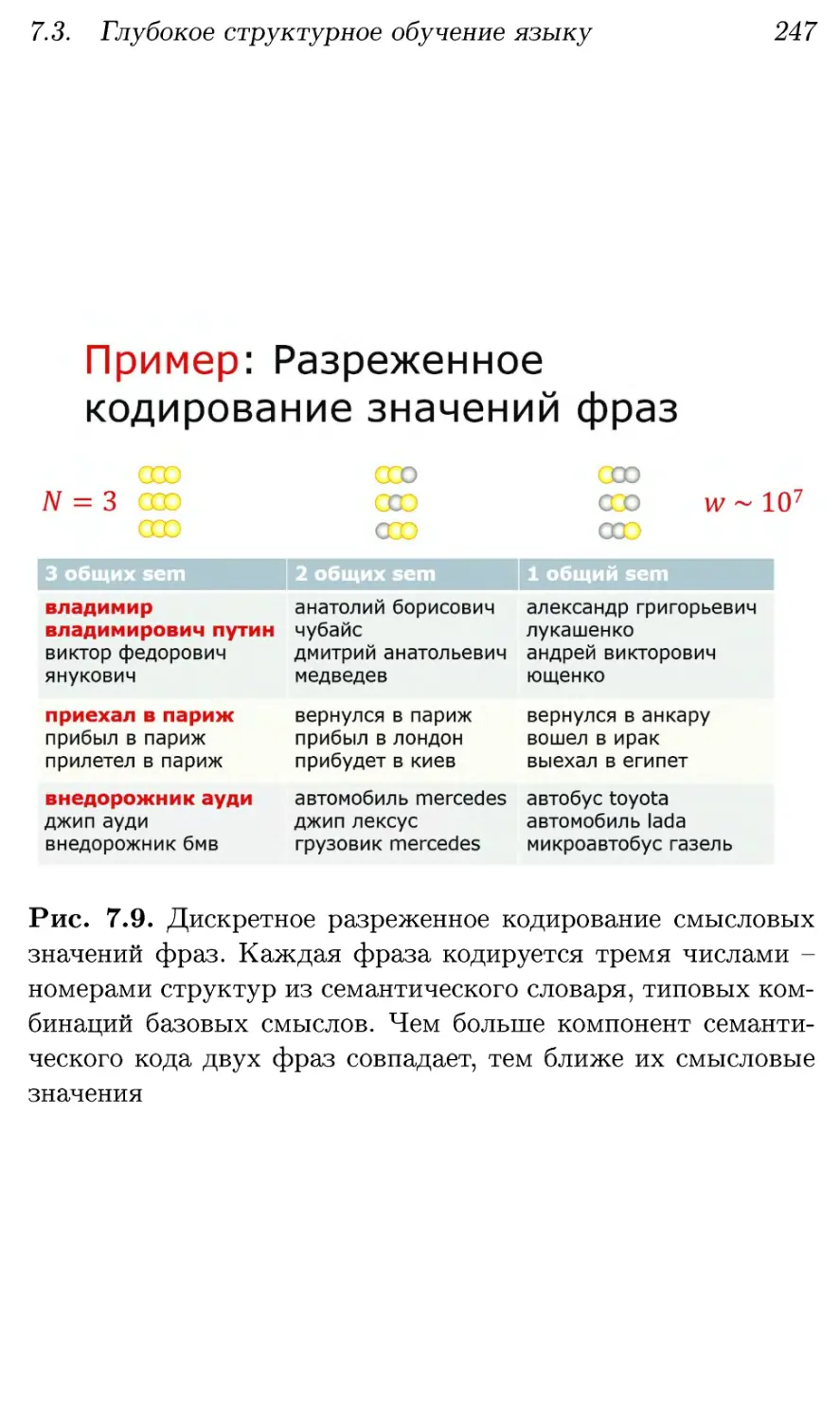

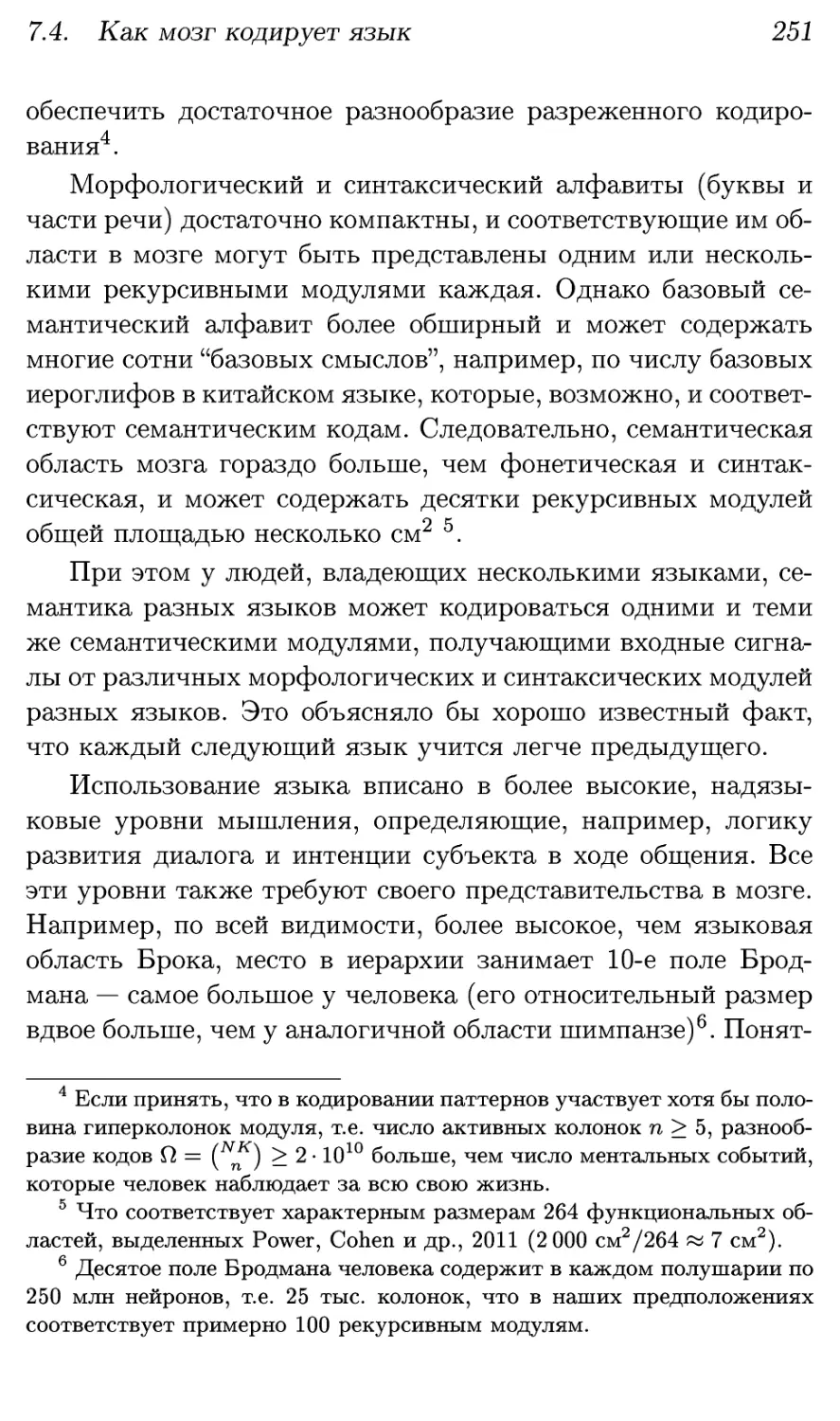

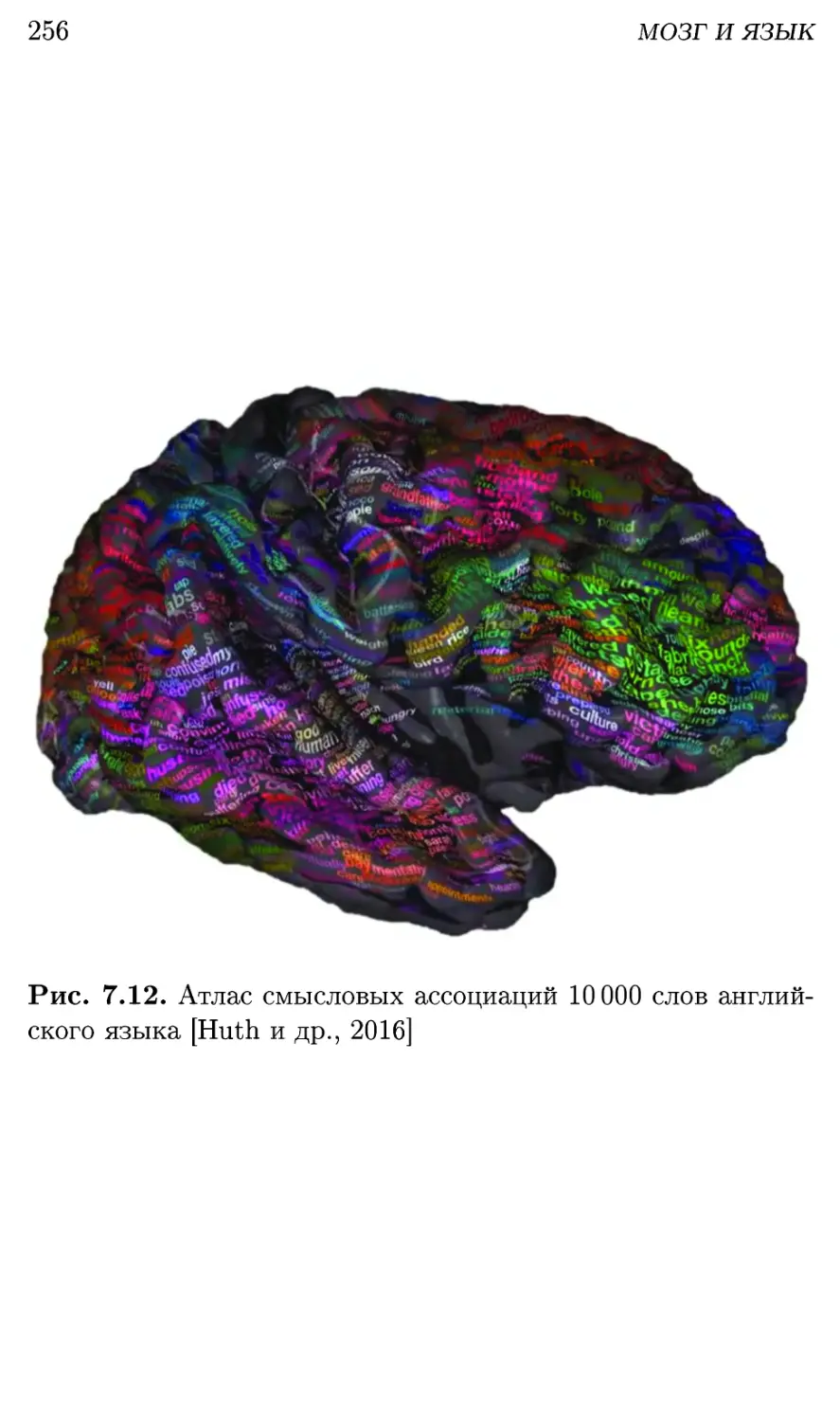

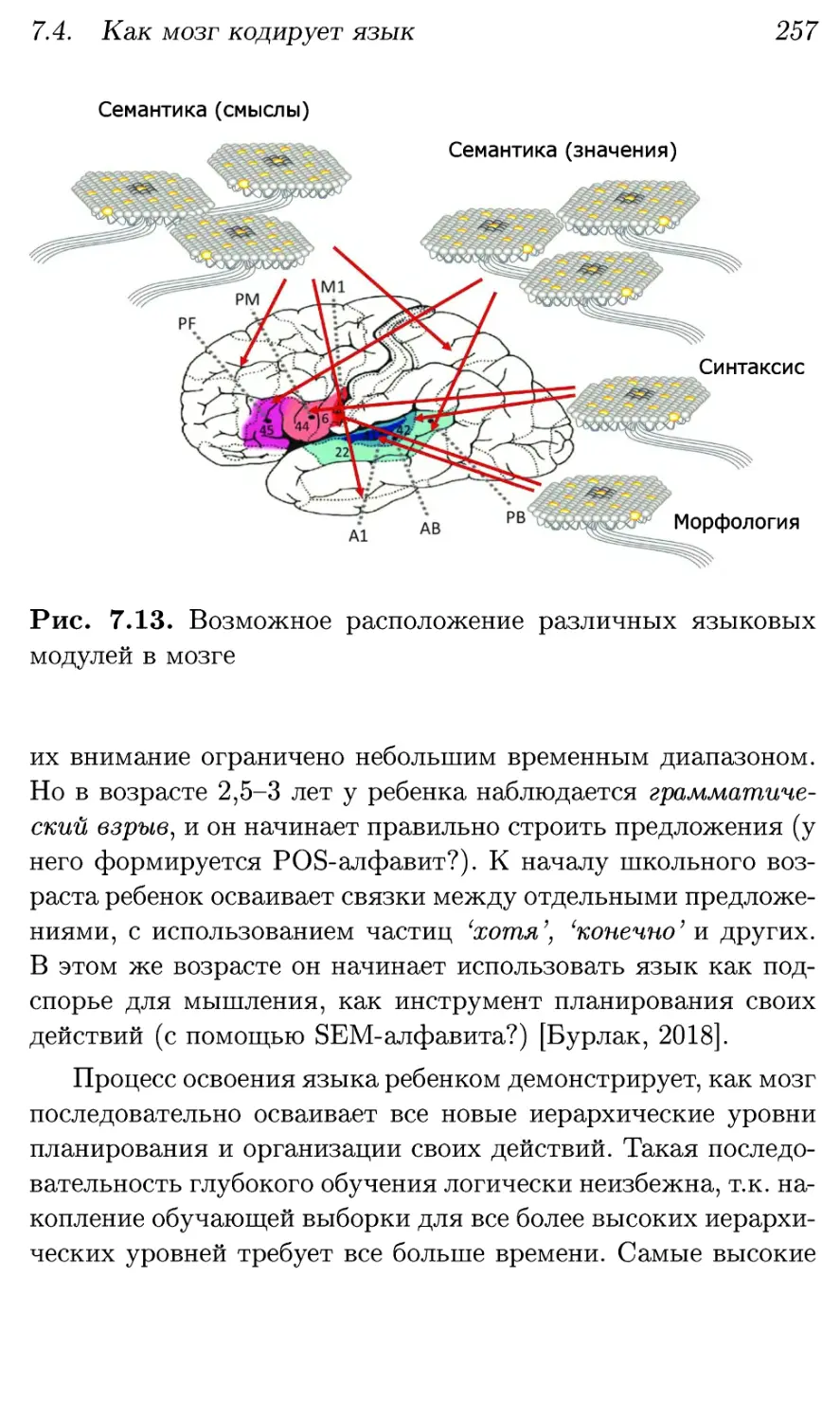

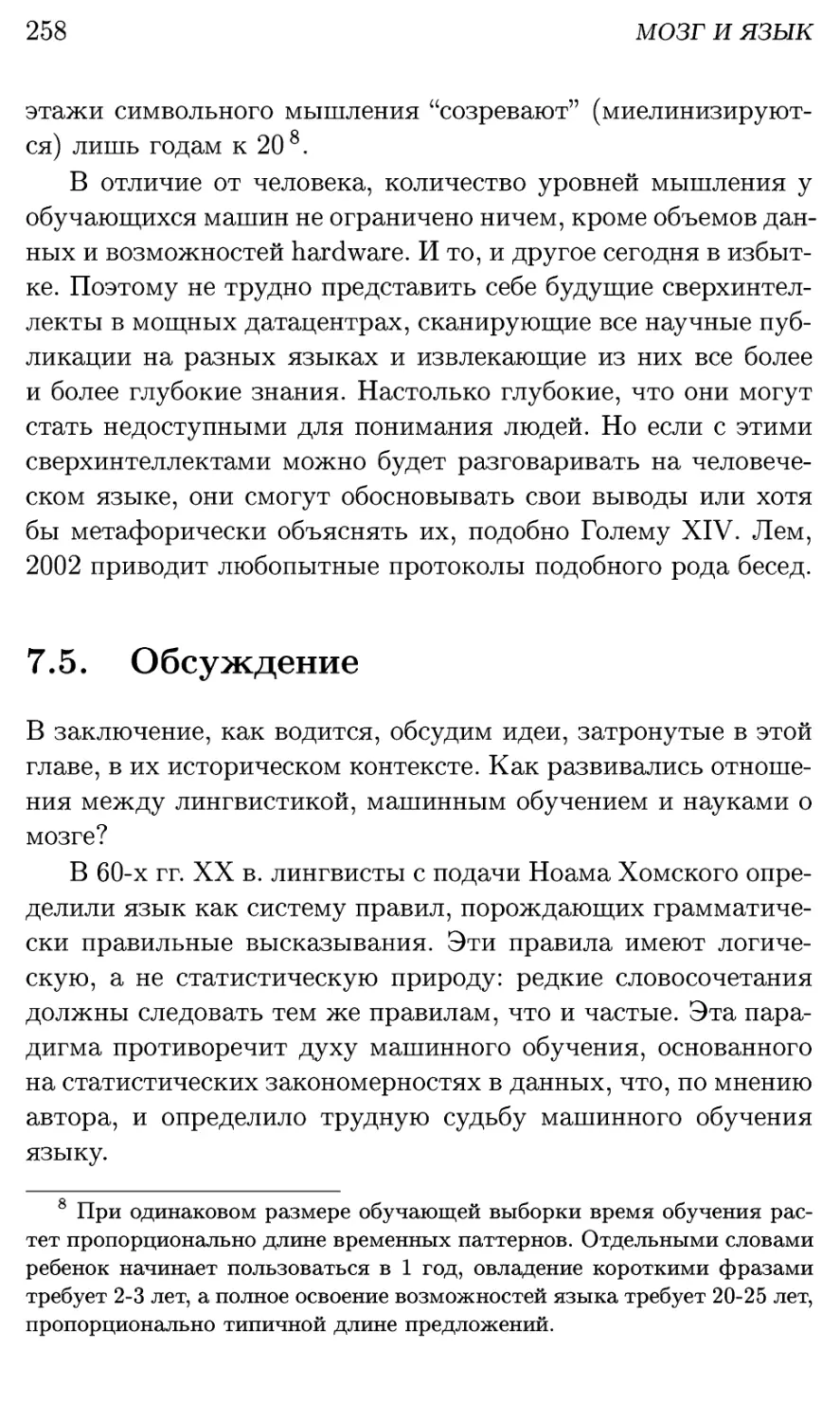

В главе 5 мы еще встретимся с принципом минимизации