Автор: Mansuy R. Mneimné R.

Теги: mathematiques algèbre algèbre linéaire réduction d'endomorphisme manuel d'algèbre linéaire vuibert édition

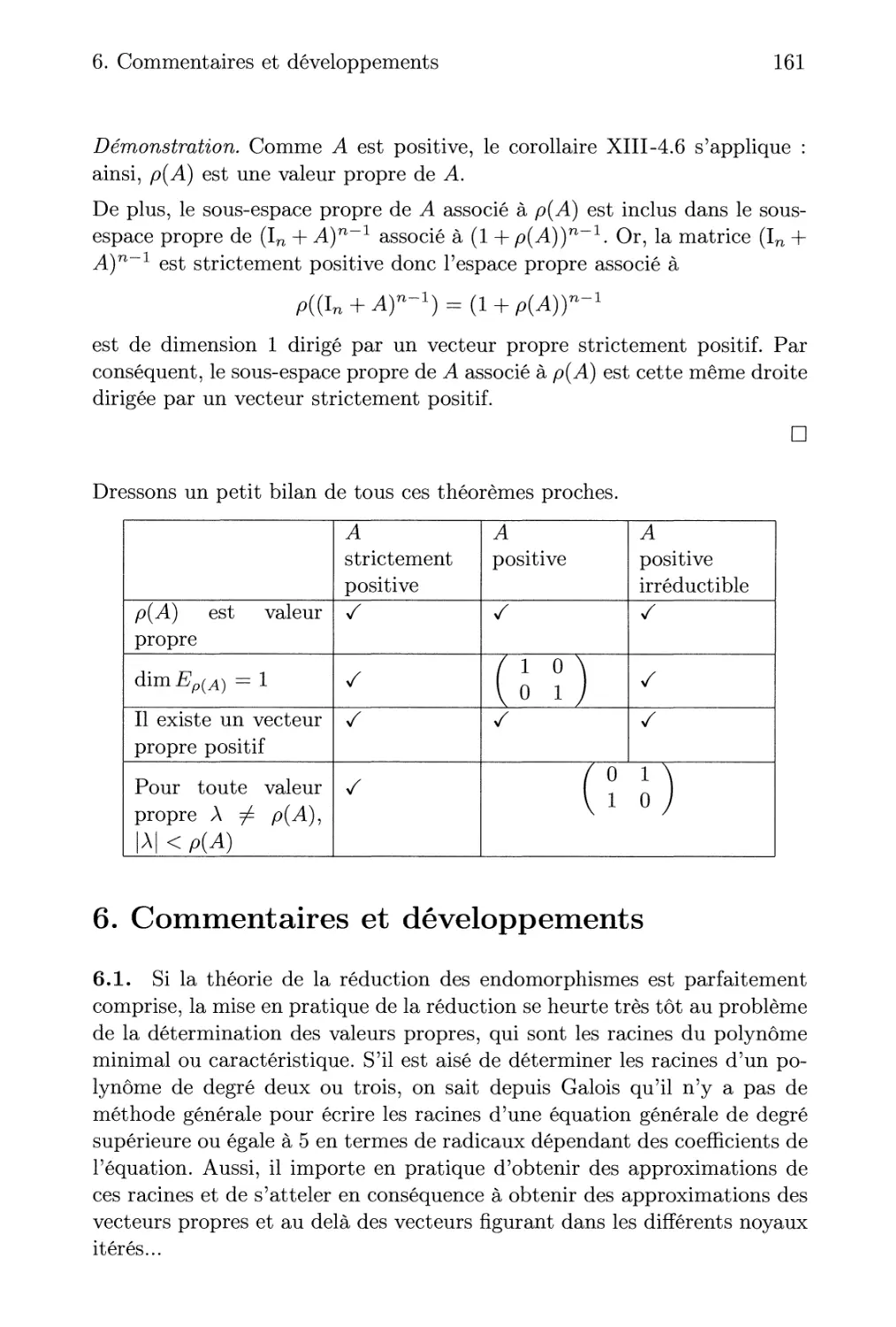

ISBN: 978-2-311-00285-0

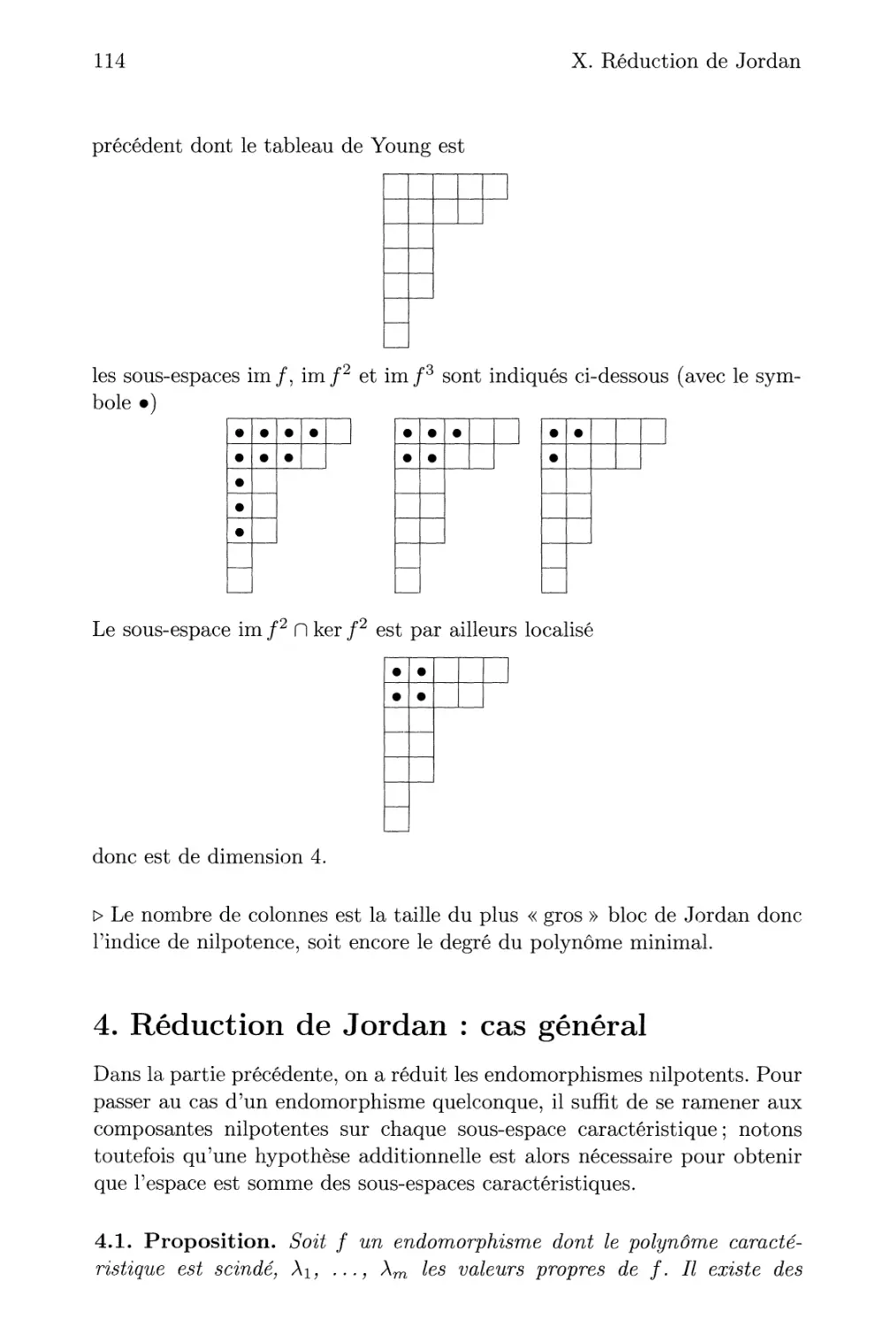

Год: 2012

Текст

Algèbre

linéaire

Réduction des endomorphismes

• Cours complet

• Commentaires et développements

• Plus de 120 exercices corrigés

Vuibert

A

Roger Mansuy

Avec la participation de Rached Mneimné

ï f*

Réduction des endomorphismes

Cours & exercices corrigés

LICENCE MATHÉMATIQUES

CLASSES PRÉPARATOIRES SCIENTIFIQUES

Vuibert

Déjà parus dans la nouvelle collection de manuels universitaires scientifiques

Éric Canon

Analyse numérique.

Cours et exercices corrigés - L2 & L3, 256 pages

Jérôme Depauw

Statistiques.

Cours et exercices corrigés - Master, 176 pages

Vincent Rivoirard & Gilles Stoltz,

Statistique mathématique en action.

Cours, problèmes d'application corrigés et mises en action concrètes - Master & Agrégation externe,

2e édition, 448 pages

Marc Briane & Gilles Pages,

Analyse. Théorie de l'intégration. Convolution et transformée de Fourier.

Cours et exercices corrigés - L3 & Master 1, 5e édition, 368 pages

Anne Cortella,

Algèbre. Théorie des groupes.

Cours et exercices corrigés - L3 & Master, 224 pages

Bruno Aebischer,

Introduction à l'analyse.

Cours et exercices corrigés - L1, 288 pages

Bruno Aebischer,

Analyse. Fonctions de plusieurs variables & géométrie analytique.

Cours et exercices corrigés - L2,448 pages

Bruno Aebischer,

Géométrie. Géométrie affine, géométrie euclidienne & introduction à la géométrie projective.

Cours et exercices corrigés - L3, 288 pages

Ariel Dufetel,

Analyse. CAPES externe et Agrégation interne.

Cours et exercices corrigés, 672 pages

et des dizaines d'autres livres de référence, d'étude ou de culture

en mathématiques, informatique et autres spécialités scientifiques

www.vuibert.fr

En couverture : Escalier en double spirale de Giuseppe Momo, Vatican.

© Sylvain Sonnet/Corbis

Maquette intérieure, composition et mise en page de l'auteur

Couverture : Linda Skoropad/Prescricom

ISBN 978-2-311-00285-0

Registre de l'éditeur : 610

La loi du 11 mars 1957 n'autorisant aux termes des alinéas 2 et 3 de l'article 41, d'une part, que les « copies ou reproductions

strictement réservées à l'usage privé du copiste et non destinées à une utilisation collective » et, d'autre part, que les analyses et les

courtes citations dans un but d'exemple et d'illustration, « toute représentation ou reproduction intégrale, ou partielle, faite sans le

consentement de l'auteur ou de ses ayants droit ou ayants cause, est illicite » (alinéa 1erde l'article 40). Cette représentation ou

reproduction, par quelque procédé que ce soit, constituerait donc une contrefaçon sanctionnée par les articles 425 et suivants du

Code pénal. Des photocopies payantes peuvent être réalisées avec l'accord de l'éditeur. S'adresser au Centre français d'exploitation

du droit de copie : 20 rue des Grands Augustins, F-75006 Paris. Tél. :01 44 07 47 70

© Vuibert - septembre 2012 - 5 allée de la 2e DB, 75015 Paris

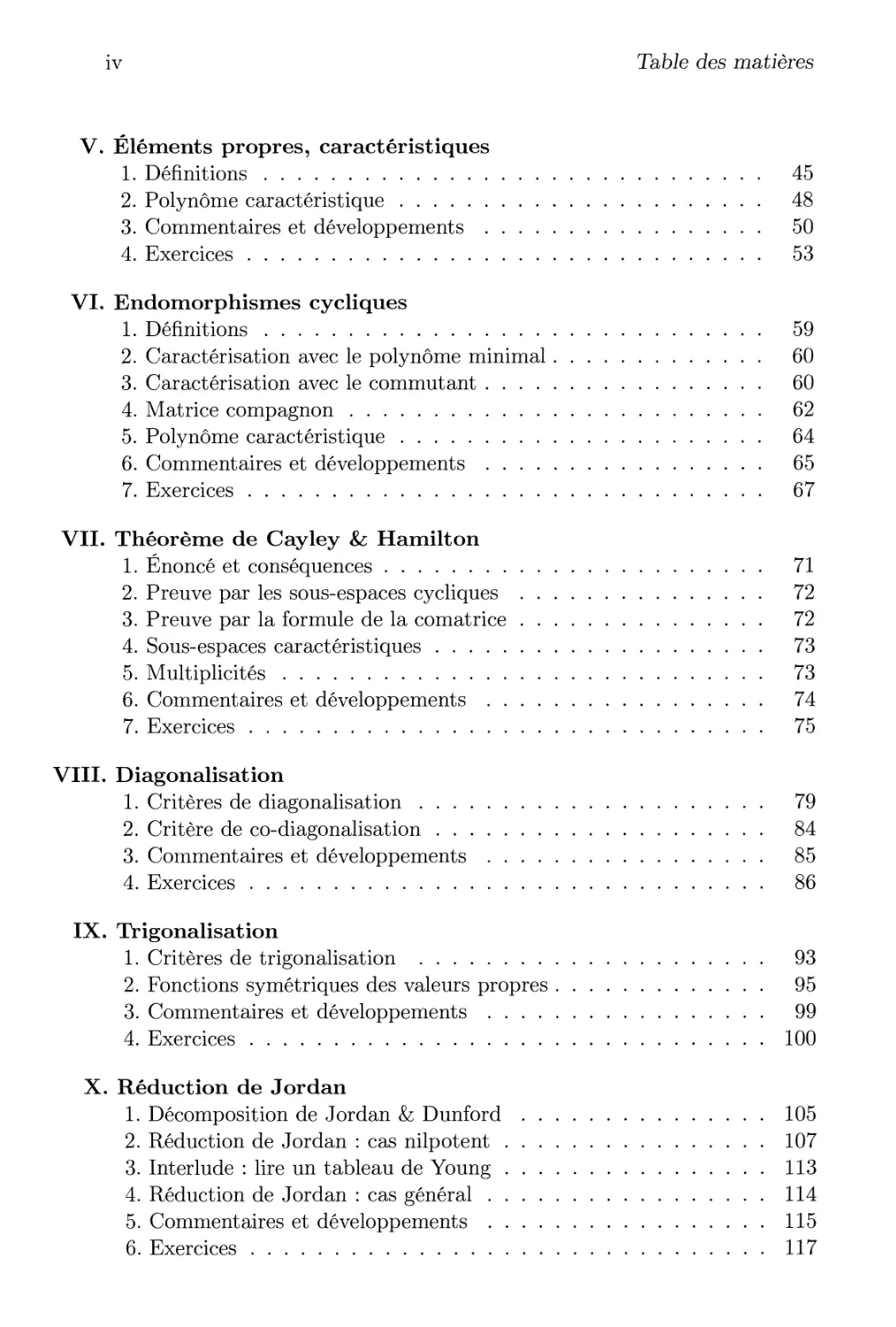

Table des matières

I. Polynômes d'endomorphismes

1. Un morphisme d'algèbre 1

2. Idéal des polynômes annulateurs 2

3. Polynôme minimal 4

4. Utilisation pratique d'un polynôme annulateur 5

5. Commentaires et développements 7

6. Exercices 9

II. Sous-espaces stables

1. Restriction d'un endomorphisme 13

2. Sous-espace stable 15

3. Endomorphisme induit sur un sous-espace stable 16

4. Exemples de sous-espaces stables 16

5. Sous-espaces cycliques 17

6. Commentaires et développements 18

7. Exercices 20

III. Commutation

1. Définitions 25

2. Calculs de commutants 27

3. Endomorphisme adf 28

4. Commentaires et développements 29

5. Exercices 30

IV. Lemme des noyaux

1. Étude de kerP(/) 37

2. Lemme des noyaux 38

3. Décomposition de l'espace en sous-espaces stables 40

4. Commentaires et développements 41

5. Exercices • . 43

iv Table des matières

V. Éléments propres, caractéristiques

1. Définitions 45

2. Polynôme caractéristique 48

3. Commentaires et développements 50

4. Exercices 53

VI. Endomorphismes cycliques

1. Définitions 59

2. Caractérisation avec le polynôme minimal 60

3. Caractérisation avec le commutant 60

4. Matrice compagnon 62

5. Polynôme caractéristique 64

6. Commentaires et développements 65

7. Exercices 67

VII. Théorème de Cayley & Hamilton

1. Énoncé et conséquences 71

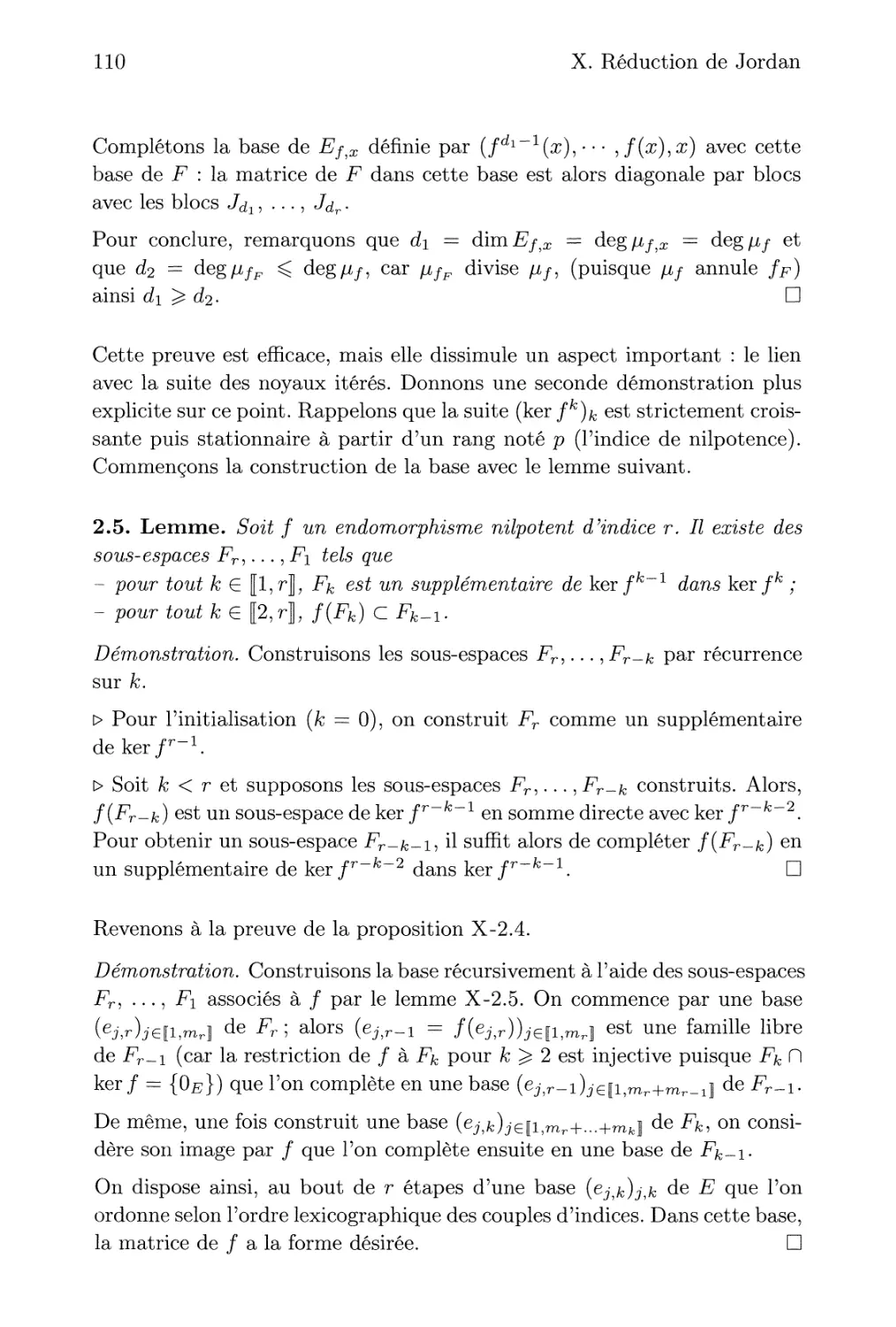

2. Preuve par les sous-espaces cycliques 72

3. Preuve par la formule de la comatrice 72

4. Sous-espaces caractéristiques 73

5. Multiplicités 73

6. Commentaires et développements 74

7. Exercices 75

VIII. Diagonalisation

1. Critères de diagonalisation 79

2. Critère de co-diagonalisation 84

3. Commentaires et développements 85

4. Exercices 86

IX. Trigonalisation

1. Critères de trigonalisation 93

2. Fonctions symétriques des valeurs propres 95

3. Commentaires et développements 99

4. Exercices 100

X. Réduction de Jordan

1. Décomposition de Jordan & Dunford 105

2. Réduction de Jordan : cas nilpotent 107

3. Interlude : lire un tableau de Young 113

4. Réduction de Jordan : cas général 114

5. Commentaires et développements 115

6. Exercices 117

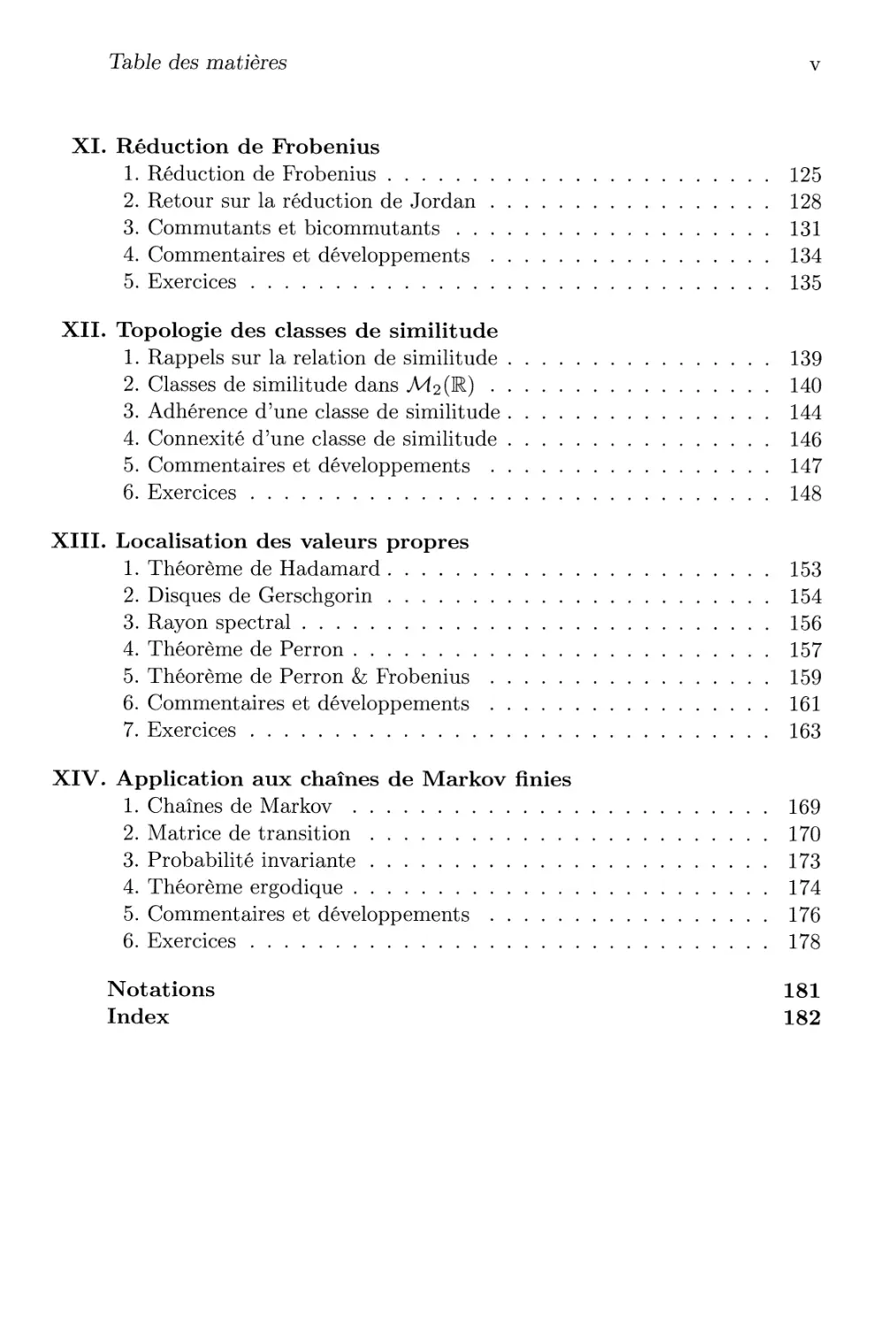

Table des matières v

XI. Réduction de Probenius

1. Réduction de Frobenius 125

2. Retour sur la réduction de Jordan 128

3. Commutants et bicommutants 131

4. Commentaires et développements 134

5. Exercices 135

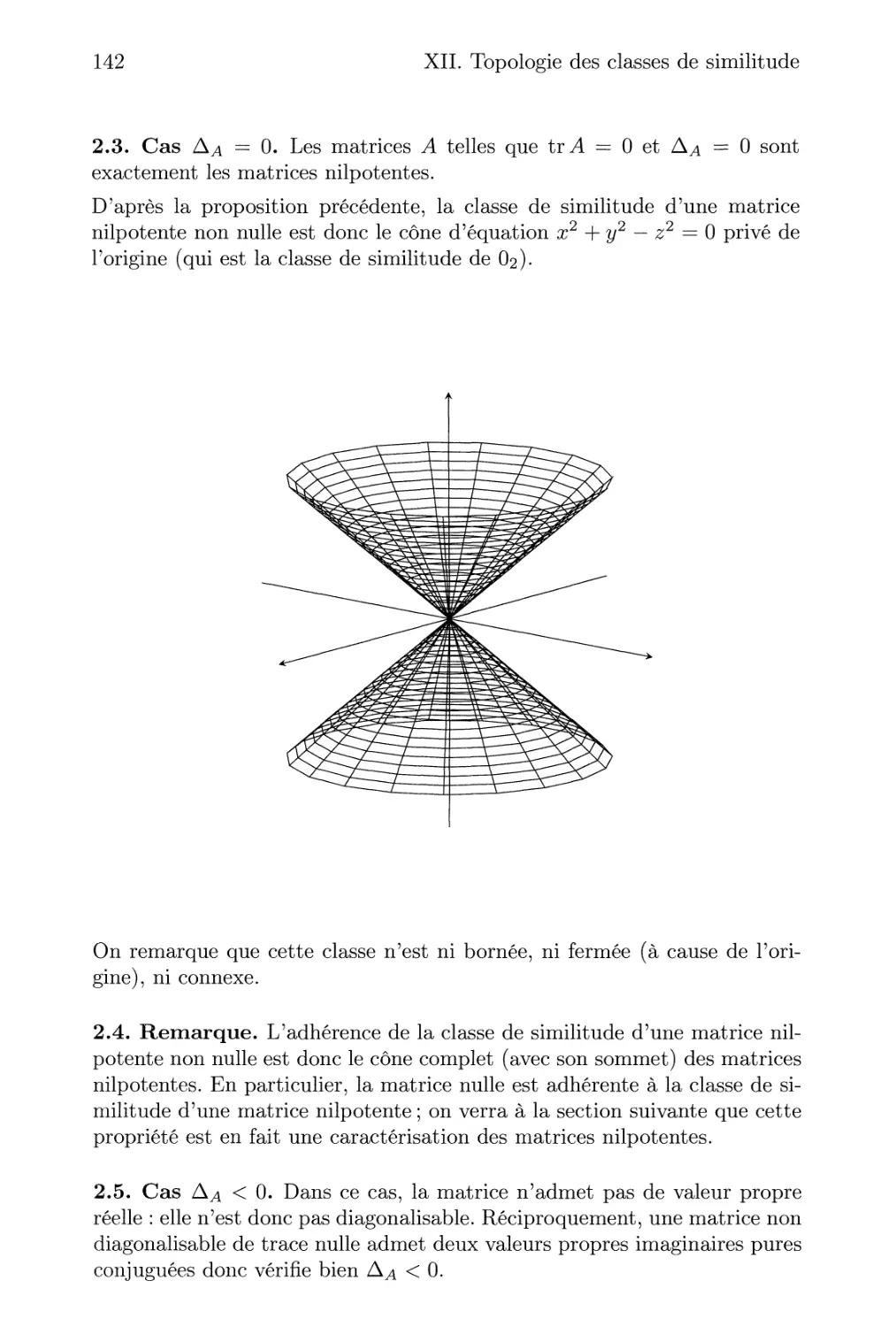

XII. Topologie des classes de similitude

1. Rappels sur la relation de similitude 139

2. Classes de similitude dans M2O&) 140

3. Adhérence d'une classe de similitude 144

4. Connexité d'une classe de similitude 146

5. Commentaires et développements 147

6. Exercices 148

XIII. Localisation des valeurs propres

1. Théorème de Hadamard 153

2. Disques de Gerschgorin 154

3. Rayon spectral 156

4. Théorème de Perron 157

5. Théorème de Perron & Frobenius 159

6. Commentaires et développements 161

7. Exercices 163

XIV. Application aux chaînes de Markov finies

1. Chaînes de Markov 169

2. Matrice de transition 170

3. Probabilité invariante 173

4. Théorème ergodique 174

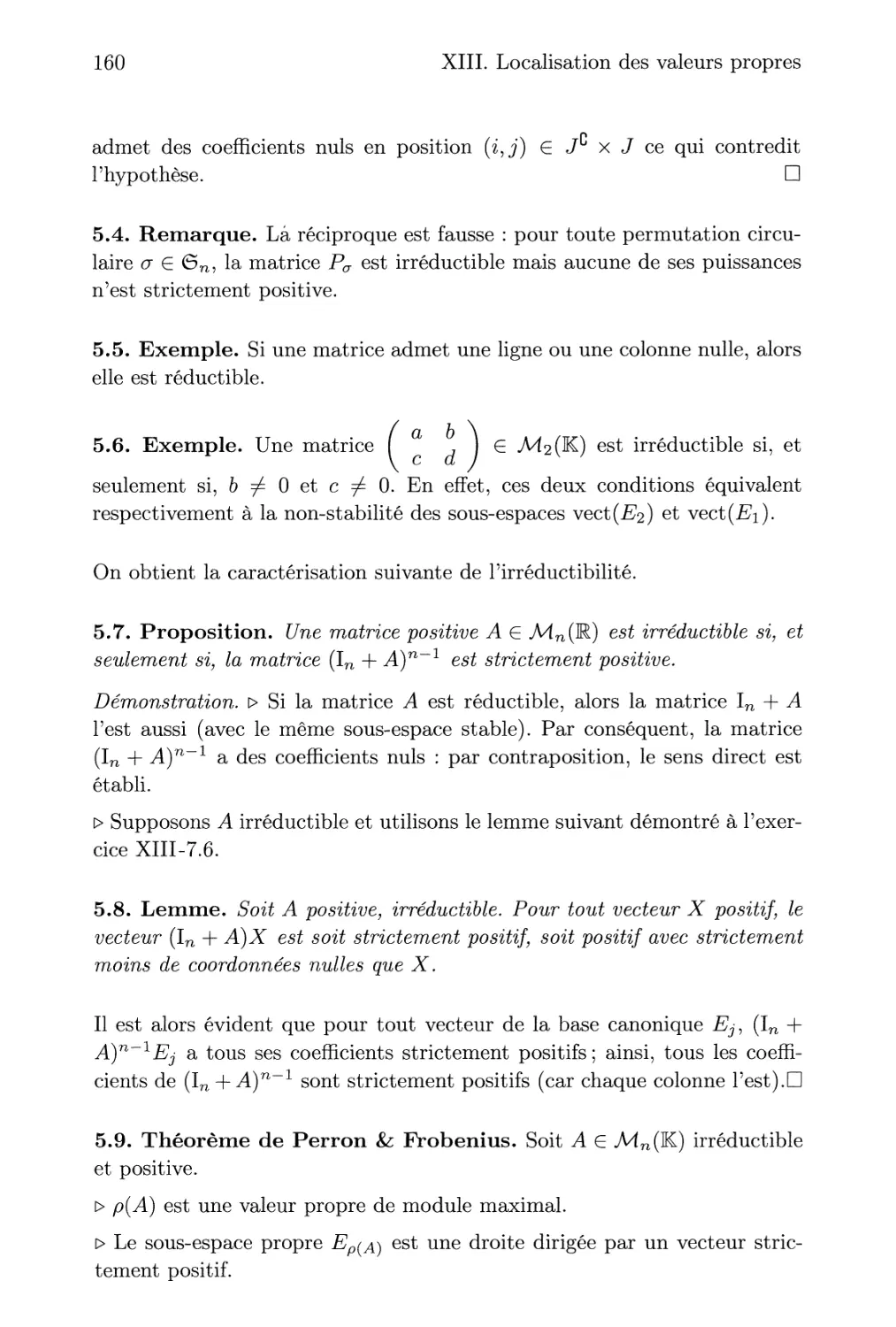

5. Commentaires et développements 176

6. Exercices 178

Notations 181

Index 182

Avant-propos

Qu'est-ce que la réduction ?

Dans tout cours d'algèbre linéaire, la réduction des matrices et des endo-

morphismes occupe une place prépondérante. Toutefois, ce terme de

réduction cache de nombreuses réalités et perspectives.

> D'une part, réduire un endomorphisme / d'un espace de dimension finie,

c'est trouver une base dans laquelle l'endomorphisme / est « bien

compris » et « facilement manipulable ». En pratique, cela revient à pouvoir

déterminer une matrice de l'endomorphisme avec une forme particulière :

diagonale (dans le meilleur des cas), diagonale par blocs, triangulaire...

Pour une matrice carrée M, l'équivalent de cette démarche consiste à

chercher une matrice d'une forme particulière semblable à M : en effet, la

formule de changement de bases pour la matrice d'un endomorphisme n'est

autre que la traduction de la similitude de deux matrices.

> D'autre part, réduire un endomorphisme (respectivement une matrice)

c'est comprendre l'ensemble de toutes les matrices qui lui sont associées

(respectivement sa classe de similitude) ; pour ce faire, on cherche une

matrice réduite qui décrit simplement, qui caractérise cet ensemble. En

avançant dans cette direction, on retrouve à la fois les invariants de similitude

(pour la réduite de Frobenius) et les tableaux de Young (pour la réduite de

Jordan).

En théorie, un cours complet comporte les deux aspects imbriqués avec

quelques applications endogènes de l'algèbre linéaire mais aussi exogènes

en provenance de l'algèbre bilinéaire, de la topologie, des probabilités, des

sciences physiques...

Qu'est-ce que ce livre ?

Il existe de nombreux livres pour les étudiants de premiers cycles qui

traitent certains des aspects de la réduction mais aucun ne semble avoir

Vlll

Avant-propos

pris la mesure de la richesse du sujet dans les cours des premiers cycles

(et dans les préparations aux concours de recrutement de l'Éducation

Nationale). Nous avons donc cherché à fournir une introduction raisonnée à

l'ensemble de la réduction. Le livre se découpe grossièrement en cinq

parties.

> Tout d'abord, les sept premiers chapitres présentent dans un ordre assez

classique les outils de la suite du livre. L'algèbre des polynômes en un

endomorphisme (respectivement une matrice carrée) joue évidemment un

rôle essentiel. Nous avons pris le parti de privilégier l'aspect élémentaire

donc de cacher, au moins en apparences, la structure de K[X]-module.

En revanche, nous avons insisté sur l'étude des sous-espaces stables de la

forme kerP(/) trop souvent limitée au lemme des noyaux et aux sous-

espaces propres et caractéristiques. Par exemple, le lemme IV-3.3 établit

l'existence d'un sous-espace cyclique maximal de dimension le degré du

polynôme minimal : ce résultat simple est riche pour la suite.

De même, nous avons choisi de mettre en exergue les endomorphismes

cycliques (chapitre VI) à la fois pour fournir une démonstration simple du

théorème de Cayley & Hamilton mais aussi pour le lemme VI-3.3 qui établit

l'existence du supplémentaire stable d'un sous-espace cyclique maximal.

L'idée est bien évidemment de préparer le terrain aux réductions de Jordan

et Frobenius en se familiarisant avec l'argument des preuves par récurrence.

> Une fois tous ces outils mis en place, deux petits chapitres décrivent les

critères simples de diagonalisation, de trigonalisation, de réduction

simultanée... Il s'agit simplement de combiner tout ce qui a été détaillé

précédemment. Cela constitue un objectif de nombreux cours de premiers cycles

mais ce n'est ici qu'un jalon dans notre parcours.

> Les chapitres X et XI présentent les deux formes réduites normalisées :

celle de Jordan et celle de Frobenius ; nous ne nous arrêtons bien

évidemment pas à l'existence de ces réductions mais nous cherchons à en montrer

l'utilité pratique avec de nombreux exercices sur les tableaux de Young ou

les algorithmes pour passer d'une forme réduite à l'autre. Il apparaît que

ces aspects sont souvent mal compris et qu'une lecture attentive de ces

chapitres serait bienvenue pour de nombreux étudiants.

> Le chapitre XII exploite les différentes caractérisations de la similitude

obtenue jusqu'à présent pour donner dans le cadre réel ou complexe des

descriptions géométriques et topologiques des classes de similitude.

> La dernière séquence du livre répond à un problématique différente : il

s'agit de chercher approximativement où se trouvent les valeurs propres

pour une matrice complexe. Ce sujet est souvent une introduction à des

problèmes d'algorithmique pour le calcul matriciel numérique ; nous avons

Avant-propos

IX

choisi d'en détailler une autre application classique avec les chaînes de Mar-

kov homogènes finies. L'application du théorème de Perron & Frobenius est

alors assez élémentaire et pourtant très parlante sur l'importance de ce

résultat.

Voilà pour le contenu du livre. Passons maintenant à la forme. Il reste

plusieurs rédactions dans ce livre qui correspondent à différents usages. Le

contenu des chapitres est présenté de manière didactique dans une démarche

très conventionnelle parsemant de nombreux exemples (certains étant très

élémentaires) l'enchaînement des propositions et leurs preuves détaillées.

Certaines preuves sont délicates et il peut être astucieux de les sauter lors

d'une première lecture afin de comprendre correctement les énoncés puis

d'y revenir plus tard à tête reposée.

Toutefois, à la fin de chaque chapitre, une section intitulée « Commentaires

et développements » détonne : il s'agit de remarques moins détaillées mais

néanmoins profondes, d'ouvertures pour permettre d'aller plus loin, il ne

s'agit plus pour nous de faire cours mais de suggérer un travail personnel. La

dernière partie de chaque chapitre est bien évidemment constituée

d'exercices ; les corrections sont détaillées pour pouvoir être lues facilement même

si nous préconisons plutôt de ne pas les lire trop vite. Certains exercices

sont relativement classiques, d'autres plus originaux : nous avons choisi de

ne pas indiquer la difficulté pour ne pas biaiser le lecteur dans son effort

de recherche.

Notations

Précisons quelques notations ou conventions (l'ensemble des notations est

détaillé dans l'index en fin d'ouvrage).

Dans tout l'ouvrage, E un ]K-espace vectoriel de dimension finie où K est

un corps quelconque (sauf précisions contraires).

Nous pratiquons abusivement l'identification d'une matrice de A4n(K) à

l'endomorphisme de Kn canoniquement associé ; cela nous amène par exemple

quelquefois à dire qu'une matrice est injective ou qu'elle laisse stable un

sous-espace.

Lorsque que nous manipulerons des matrices par blocs, seuls les blocs non

nuls seront représentés : les espaces « vides » sont à compléter avec des

coefficients nuls.

X

Avant-propos

Remerciements

Un grand remerciement va aux relecteurs (anciens élèves, collègues et amis)

qui ont sacrifié une partie de leurs vacances estivales pour débusquer nos

coquilles et autres imprécisions : Yixin SHEN, Pierre Bayle, Anne-Laure

Biolley, Marc Yuma Chapuis, Mohammed Hawari, Ulysse Mizrahi.

Chapitre I

Polynômes

d ' endomor phismes

Objectifs du chapitre

- Comprendre l'importance de l'algèbre K[f] associée à l'endomorphisme

/•

- Calculer sur des exemples simples le polynôme minimal d'un

endomorphisme.

- Utiliser les polynômes annulateurs pour calculer puissances ou inverse

(s'il existe).

1. Un morphisme d'algèbre

1.1. Définition. Soit / G C{E). Pour tout polynôme P G K[X] de la

N

forme P(X) = Yl akXk, l'endomorphisme P(f) est défini par

k=0

N

p(f) = J2a«fk-

k=0

1.2. Exemple. Par exemple, pour le polynôme P = X3 + 2X — 1 et un

endomorphisme /, l'endomorphisme P(f) vaut /3 + 2/1 — f° — /3 + 2/ —Id.

2

I. Polynômes d'endomorphismes

1.3. Remarque. Pour toute matrice A G Mn(K) et tout polynôme P G

K[X], on définit de même la matrice P(A). Il est important de remarquer

que si A est la matrice d'un endomorphisme / dans une base B, alors P(A)

est la matrice de l'endomorphisme P(f) dans cette même base B.

1.4. Remarque. Attention aux erreurs de notation entre polynômes et

polynômes en /. Par exemple, on veille bien à ne pas mélanger les écritures

suivantes pour P, Q G K[X], f G C(E) et x G E :

- P(f)(x), qui est un vecteur et P{f(x)) qui n'est pas défini;

- (P • Q)(f) = P{f) ° Q(f), qui est un endomorphisme et (P o Q)(f) qui

est un autre endomorphisme.

1.5. Proposition. Soit f G C(E). L'application qui à un polynôme P G

K[X] associe l'endomorphisme P(f) G C{E) est un morphisme d'algebres.

L'image de ce morphisme, notée K[f], est une sous-algèbre commutative

deC(E).

1.6. Proposition. Soit f G C(E) et deux polynômes P et Q. Alors, les

endomorphismes P(f) et Q(f) commutent.

Démonstration. Par linéarité, il suffit de noter que, pour tous m et n G N,

rm rn £m-\-n £n rm

n

2. Idéal des polynômes annulâteurs

2.1. Définition. Soit / G C(E) et P G K[X]. Un polynôme P est annula-

teur de / si l'endomorphisme P(f) est l'endomorphisme nul.

2.2. Remarque. Comme précédemment, cette notion est définie de

manière analogue pour une matrice carrée.

2.3. Proposition. Tout endomorphisme d'un espace vectoriel de

dimension finie admet un polynôme annulateur non nul.

Démonstration. Soit / un endomorphisme d'un K-espace vectoriel E de

dimension n. Alors, la famille (fk)kelo,n2j comporte n2 + 1 vecteurs de

l'espace £(E), lequel est de dimension n2 : elle est alors liée. Il existe donc

2. Idéal des polynômes annulateurs

3

2 il

une famille de (<^/c)/ce[o,n2] £ ^n de scalaires non tous nuls telle que

n2

fc=0

n2

Par conséquent, le polynôme Yl akXk est annulateur de /. □

k=0

2.4. Remarque. Nous verrons plus loin (théorème de Cayley & Hamilton)

qu'en dimension n, on peut déterminer un polynôme annulateur de degré n

(le polynôme caractéristique).

2.5. Exemple. Le seul endomorphisme qui admet aX+b comme polynôme

annulateur avec a ^ 0 est l'homothétie de rapport — —.

En dimension infinie, il existe des endomorphismes qui n'admettent pas de

polynôme annulateur non nul.

2.6. Exemple. La dérivation usuelle D : P H> P' est un endomorphisme

de K[X] qui n'admet pas de polynôme annulateur.

En effet, raisonnons par l'absurde : si D admet un polynôme

annulateur Q, alors, pour tout polynôme P G 1K[X], Q(D)(P) = 0. Or, avec P =

^degQ+i^ Q(D)(P) ^ 0 : contradiction.

2.7. Définition. Un endomorphisme est nilpotent s'il admet un monôme

comme polynôme annulateur.

2.8. Proposition. L'ensemble Xf des polynômes annulateurs de

l'endomorphisme f est un idéal de l'anneau K[X].

Démonstration. L'ensemble Xf est clairement un sous-groupe additif de K[X].

Si P G Xf et Q G K[X], alors QP G !/, car

(QP)(f) = Q(f) ° P(f) = Q(f) ° 0c(E) = 0C(E).

D

2.9. Remarque. Pour / G C(E) et x G E, on peut aussi définir l'ensemble

If,x = {P£K[X], P(f)(x) = 0E}.

C'est encore un idéal de K[X] et il vérifie Xf C Xf^x.

4

I. Polynômes d'endomorphismes

3. Polynôme minimal

Comme l'anneau K[X] est euclidien, il est en particulier principal, donc

chaque idéal de K[X] peut être engendré par un unique polynôme unitaire.

Ceci justifie la définition suivante (conjointement avec l'hypothèse que

l'espace E est de dimension finie donc que l'idéal des polynômes annulateurs

est non réduit au seul polynôme nul).

3.1. Définition. Soit / G C{E). Le polynôme minimal de / est l'unique

polynôme unitaire, noté /z/, qui engendre l'idéal des polynômes annulateurs

de/.

3.2. Remarque. Il est facile de voir que, pour un endomorphisme /, la

dimension de l'algèbre K[f] est le degré du polynôme minimal fif. La

proposition 1-4.4 détaille cette remarque.

Déterminons l'idéal des polynômes annulateurs de quelques endomorphismes

remarquables.

3.3. Exemple. Si / est un endomorphisme nilpotent, il admet un polynôme

annulateur de la forme Xp. Par conséquent, le polynôme minimal est donc

un monôme Xk avec k < p. Cet entier k est appelé indice de nilpotence de

/. Un polynôme est alors annulateur e / si 0 en est une racine d'ordre au

moins k.

3.4. Exemple. Si h est une homothétie de J5, il existe À G K tel que h =

Àldjç. Par conséquent, X — À est un polynôme annulateur de degré 1, donc

minimal. Un polynôme annulateur de h est donc un multiple de X — À,

c'est-à-dire un polynôme admettant À comme racine.

3.5. Exemple. Si p est un projecteur, alors un polynôme annulateur de p

est, par définition, X2 — X. Ce polynôme est le polynôme minimal de p

sauf si p est l'identité ou l'application nulle (en effet, s'il n'est pas minimal,

alors p admet un polynôme annulateur de degré 1, donc est une

homothétie).

3.6. Exemple. De même, le polynôme minimal d'une symétrie vectorielle

qui n'est pas une homothétie (c'est-à-dire différente de ±Id#) est X2 — 1.

3.7. Définition. Soit / G C(E) et x G E. Le polynôme minimal local en x

de / est l'unique polynôme unitaire, noté /x/,œ> qui engendre l'idéal XfiX des

polynômes P G K[X] tels que x G kerP(J).

4. Utilisation pratique d'un polynôme annulateur

5

4. Utilisation pratique d'un polynôme

annulateur

Calcul de l'inverse

4.1. Proposition. Soit f G C(E) admettant un polynôme annulateur P

tel que P(0) ^ 0. Alors, f est inversible. De plus, son inverse appartient à

l'algèbre K[f].

N

Démonstration. Écrivons P(X) = Yl akXk avec N > 0 et ao = -P(O) ^ 0.

k=0

Posons

k=i

Comme P(f) = 0c{e)^ on obtient en isolant le terme en Id^;,

f°g = ^o/ = o£(E).

Ainsi, / est inversible et que f~x — g. □

4.2. Exemple. Soit / un endomorphisme de E qui vérifie

(/ - 2Id) o (/ - 3Id) = 0

sans être une homothétie. Cherchons les réels À tels que h\ = f — Àld soit

non inversible (nous verrons plus loin que ces réels sont, par définition, les

valeurs propres de /). Comme le polynôme (X — 2){X — 3) est annulateur

de /, on en déduit que (X + X — 2)(X-\-X — 3) est annulateur de h\. Donc, si

À ^ {2,3}, l'endomorphisme h\ est inversible, car son polynôme annulateur

n'admet pas 0 pour racine. En revanche, ni /12, ni /13 ne sont inversibles, car

sinon l'autre est nul (et donc / est une homothétie) puisque h^ o /13 = 0.

La réciproque du résultat précédent est bien évidemment fausse avec un

polynôme annulateur quelconque : si P est un polynôme annulateur de /,

alors XP est aussi annulateur et admet 0 pour racine, que / soit inversible

ou non. En revanche, la situation est plus claire avec le polynôme minimal.

4.3. Proposition. Un endomorphisme f G C(E) inversible si, et seulement

si, 0 n'est pas racine de son polynôme minimal.

6

I. Polynômes d'endomorphismes

Démonstration. Avec la proposition précédente, il suffit d'étudier le sens

direct. Supposons que / est inversible et que 0 est racine du polynôme

minimal fMf de /, c'est-à-dire /jif = XP. On en déduit foP(f) = $c(E) \ or? f

inversible et par conséquent P(f) = Oc(e)> ce Qui contredit la minimalité

de fif. Par conséquent, 0 n'est pas racine du polynôme minimal. □

Calculs de puissances

4.4. Proposition. Soit f G C(E) admettant un polynôme annulateur de

degré N. Alors, pour tout entier m G N, fm G vect(/fe)fc€|0,jv-i]-

Démonstration. Soit / G C(E) de polynôme annulateur P de degré N

et m G N. D'après la division euclidienne dans K[X], il existe (Qm,i?m) £

K[X]2 tel que

Xm = Qm(X)P(X)-hRm(X),

avec degRm < degP = N. Alors, on trouve que /m = iïm(/), d'où le

résultat. □

En fait, on peut aussi utiliser en pratique la démonstration de ce

résultat pour obtenir l'expression explicite de fm pour tout entier m G N. Il

suffit pour cela de savoir obtenir le reste dans une division de polynômes.

Détaillons les calculs dans quelques cas particuliers.

4.5. Exemple. Soit (a, b) G C avec a ^ b et / un endomorphisme dont un

polynôme annulateur est

P(X) = (X-a)(X-b).

Déterminons fm pour tout entier m G N. Le reste de la division euclidienne

de Xm par P est un polynôme de degré au plus 1 que nous noterons amX-\-

/3m. Reste à déterminer les valeurs des complexes am et /?m. Pour cela,

spécifions la relation de division euclidienne en a et en b :

( am = a 'dm + Jim

\ 6- = b-am + pm

am _ yn b • am — a - b171

En conclusion, f171 = —/ H Id#.

a — b b — a

4.6. Remarque. Plus généralement, la même méthode permet de traiter

le cas où / annule un polynôme scindé à racines simples Ai,..., Àp. On a

5. Commentaires et développements

7

alors, pour tout m G N,

/m = ]TA^Lfe(/),

fc=0

où Li,..., Lp désignent les polynômes interpolâteurs de Lagrange associés

aux Ai,..., Àp.

Lorsque le polynôme annulateur est scindé mais avec des racines multiples,

le problème est à peine plus compliqué et se ramène à un problème

d'interpolation.

4.7. Exemple. Déterminons les puissances d'un endomorphisme / de

polynôme annulateur (X — a)2.

Soit m un entier. Le reste de la division euclidienne de Xm par (X — a)2

est un polynôme de degré au plus 1 que nous noterons amX + /3m. On a

donc : Xm = Q(X)(X — a)2 + amX + fîm. Reste à déterminer les valeurs

des complexes am et /3m. Pour cela, nous spécifions cette relation en a puis

dérivons cette relation avant de spécifier en a (tous les termes où apparaît Q

s'annulent, car a est racine double de (X — a)2). Nous obtenons :

am = a • am + /3m

m • am_1 = am.

En conclusion, fm — m • am_1/ + (1 — ra) • amId£.

5. Commentaires et développements

5.1. La donnée d'une matrice A met en évidence le morphisme d'algèbre

^ f K[X] -> .Mn(K)

$A\ P ^ P{A)

Son noyau, l'idéal ker <£>a> est non nul, pour des raisons de dimension. Il est

engendré par le polynôme minimal \xa \ l'image im §a — ^{A} est une sous-

algèbre de .Mn(K), dont la dimension se déduit aisément de l'isomorphisme

de K-algèbres

^:K[X}/(fiA)^K[A}.

Ainsi, la dimension de l'algèbre ~K[Â\ est égale à celle de l'espace vectoriel

quotient K[X]/(iia). C'est donc le degré dA du polynôme minimal jjla de la

matrice A. En effet, les vecteurs 1, X, ..., XdA~1 forment une base de cet

espace quotient. Le fait que ces vecteurs soient générateurs provient d'une

8

I. Polynômes d'endomorphismes

simple division euclidienne par le polynôme jjla et le fait qu'ils soient libres

provient du caractère minimal de /j,a-

Cela se traduit au niveau de l'algèbre K[A] par le fait que les matrices In,

A,..., AdA~1 forment une base de l'algèbre des polynômes en A.

5.2. La structure de l'algèbre K[A] est donc celle d'un quotient d'un anneau

de polynômes en une seule variable. Elle dépend uniquement du polynôme

minimal de A. La structure de ces quotients-là, comme celle des anneaux

Z/nZ, est bien connue et son étude se trouve grandement simplifiée par

le théorème des restes chinois, qui montre que cette algèbre est produit

d'algèbres locales, c'est-à-dire d'algèbres ayant chacune un idéal maximal

unique (et pour une telle algèbre le treillis de leurs idéaux est alors une

liane...).

5.3. Précisons donc que si le polynôme minimal est une puissance d'un

polynôme irréductible, soit ha = 7rm avec tt irréductible, l'algèbre quotient

K[X]/(ij,a), tout comme l'algèbre K[A], est une algèbre locale et son idéal

maximal est l'idéal m = (tt) engendré par la classe du polynôme tt. La

démonstration est calquée sur celle de la mise en évidence des idéaux de

l'anneau quotient Z/_pnZ, où p est premier.

5.4. Comme autre application, remarquons que l'algèbre K[A] est réduite

(au sens qu'elle n'a d'autres nilpotents que 0n) si, et seulement si, le

polynôme minimal de A est sans facteur carré. Quand K = C, cela revient à dire

que l'algèbre K[A] est un produit de corps isomorphes à C. On verra une

démonstration de ce fait ultérieurement (chapitre X) avec la décomposition

de Jordan & Dunford.

5.5. Nous avons vu que l'algèbre K[A] contenait l'inverse de A si A est

inversible. On verra plus tard que les composantes semi-simple et nilpotente

dans la décomposition de Jordan & Dunford de A sont aussi dans K[A],

tout d'ailleurs comme les opérateurs de projection sur les facteurs directs

de la décomposition de E en somme d'espaces caractéristiques. Tout cela

pour dire qu'au delà de sa structure elle-même, l'algèbre ~K[A] contient de

part ses divers éléments des renseignements précieux.

5.6. L'idéal des polynômes annulateurs de A en le vecteur x est le noyau de

l'application <&a,x : K[X] —> E, qui, à un polynôme P, associe le vecteur

P(A)(x). Cette application est une simple application linéaire et, pourtant,

son noyau est un idéal ! En fait, cette application est K-linéaire, mais elle

est aussi K[X]-linéaire, au sens que $a,x(PQ) = P{A){§a,x{Q))> C'est en

6. Exercices

9

fait un morphisme de K[X]-modules et son noyau est donc un sous-K[X]-

module de K[X], donc un idéal de K[X].

5.7. Le groupe des inversibles de l'algèbre K[A] est l'ensemble des matrices

Q(A) où Q est un polynôme premier avec /x^.

6. Exercices

6.1. Exercice. Soit A, B G Ain{K) deux matrices semblables et P G K[X].

Montrer que les matrices P(A) et P(B) sont semblables.

D> Eléments de correction. Par définition de la similitude, il existe U G

GLn(K) telle que A = UBU~l. Par une récurrence immédiate, pour tout k G

N, Ak = UBkU~~l ; ainsi, par linéarité P{A) = UP{B)U~l. <

6.2. Exercice. Soit A G Mn(M.) une matrice semblable à une matrice

diagonale diag(Ài,..., An). Montrons qu'il existe P G K[X] tel que A =

P(A3).

> Éléments de correction. Par définition, il existe U G GLn(K) telle que A =

C/diag(Ai,..., An)?7_1 et donc

A3 = Udmg(Xl...,X3n)U-1.

Considérons le polynôme P d'interpolation de Lagrange qui vaut, pour

tout k G [1, n], A/e en A| (ce qui est possible car Aj* — A| entraîne A& = Xj).

Alors, diag(Ai,..., An) = P(diag(A?,..., A3)) et donc A = P(A3). <

6.3. Exercice. Soit f G C(E) ; définissons V endomorphisme de C(E)

associé par composition à gauche Gf : g —>> / o g. Comparer jif et ficf ■

D> Éléments de correction. Remarquons tout d'abord que, pour tout P G

K[X] et tout g G C(E), P(Gf)(g) = P(f) o g. Ainsi, /j,f est annulateur

de G/.

De plus, pour tout g G £(P), /xG/(/) o g = 0C(e) donc ^G/(/) = Oc(E)

et /iG/ est annulateur de /.

En conclusion, /i/ = ncf • <l

6.4. Exercice. Soit n ^ 2 et M e Mn(K) une matrice de rang 1.

7. Montrer que \iM = X2 - tr(M)X

#. En déduire les puissances de M en fonction de M etln.

10

I. Polynômes d'endomorphismes

D> Éléments de correction. On montre facilement qu'il existe des vecteurs

colonnes non nuls X, Y G Mn,i(K) tels que M = iV.

1. La matrice M n'est pas une homothétie donc le polynôme minimal est

au moins de degré 2. De plus,

M2 = XYxY = (Vl)M,

car YX est un scalaire. Or, YX = tr(YX) = tr(XY) = tr(M). Ainsi,

X2-tr(M)X est annulateur de M. En conclusion, /iM = X2-tr(M)X.

2. Pour calculer la puissance Mfc, effectuons la division de Xk par /im-

> Si tr(M) = 0, alors Mk = 0n dès que k ^ 2.

> Sinon, il existe un polynôme Q G K[X] tel que

Xfc = Q(X)Mm(X) + t^M)*"1*.

En effet, le reste dans la division de Xk par \xm est un polynôme de

degré au plus 1, qui est nul en 0 et qui vaut tr(M)fc en trM. Ainsi,

Mk = tv{M)k-lM pour tout k ^ 1.

Remarquons que ce résultat peut aussi être déduit par une simple

récurrence.

<

6.5. Exercice. Déterminer, en fonction de n = dimE ^ 2, le polynôme

minimal de Vendomorphisme

C(E) -+ C(E)

f ^ f + tr(f)ldE

D> Eléments de correction. L'endomorphisme $ n'est pas une homothétie,

donc son polynôme minimal est de degré au moins 2.

Par ailleurs, pour tout / G £{E),

*2(/) = <*>(/)+tr($(/))IdE

= / + tr(/)Ids + tr(/)IdB + ntr(/)Ids

= /+(n + 2)tr(/)IdB

= (n + 2)$(/)-(n + l)Id£(B)(/).

En conclusion, /z$ = X2 - (n + 2)X + (n + 1). <

6.6. Exercice. 5oii / e C{E). Notons, pour tout x £ E, \ijyX le ■polynôme

minimal de f local en x, c'est-à-dire l'unique polynôme unitaire engendrant

l'idéal

lftX = {PeK[x], P(f)(x) = oE}.

Montrer que Vensemble {/i/^, x e E} est fini.

.,{

6. Exercices

11

> Eléments de correction. Remarquons que, pour tout x G E1 fif{f)(x) =

Oe donc /if G Xf^x et par conséquent fif^x divise fif. Comme fif admet un

nombre fini de diviseurs unitaires (et l'on peut calculer ce nombre à partir de

la décomposition en facteurs irréductibles de /x/), l'ensemble {fif,x, % G E}

est fini. <

6.7. Exercice. Soit f G C(E) et P e K[X}. Montrer que P(f) est

inversible si, et seulement si, P est premier avec fif.

> Eléments de correction. Remarquons tout d'abord que si un endomor-

phisme de la forme P(f) est inversible, alors son inverse est aussi dans

l'algèbre K[/].

Soit P G K[X]. L'endomorphisme P(f) est inversible si, et seulement si, il

existe Q G K[X] tel que P(f) o Q(f) = Id^;, c'est-à-dire si PQ — 1 est un

multiple de fif. D'après le théorème de Bézout, cette dernière condition est

équivalente à P et fif premiers entre eux.

On peut noter que Valgorithme d'Euclide (étendu) nous fournit ici Vinverse.

Cet exercice montre donc K[/] est un corps si, et seulement si, le polynôme

minimal fif est irréductible sur K. <

6.8. Exercice. Soit f G C(E) et J = {P G K[X], P(f) est nilpotent}.

Montrer que J est un idéal puis déterminer, en fonction de fif, un élément

générateur.

> Éléments de correction. > Soit P et Q e J. Les endomorphismes P(f)

et Q(f) sont nilpotents et commutent donc l'endomorphisme (P — Q)(f)

est nilpotent d'après la formule du binôme avec pour exposant la somme

des indices de nilpotence : P — Q G J.

> Soit P G J et R G K[X}. L'endomorphisme P{f) est nilpotent et R(f)

et P(f) commutent donc {RP)(f) = R(f)n o P(f)n = 0C(e)- Ainsi, on

obtient RP G J.

En conclusion, J est un idéal.

Enfin, notons que P appartient à J" si, et seulement si, fif divise Pn c'est-

à-dire fif divise P où fïf est le produit des facteurs irréductibles distincts

de fif. Un générateur est donc ce polynôme fif. <

6.9. Exercice. Soit A, B G A^n(K) et un polynôme P G K[X] non

constant tel que P(0) ^ 0 et AB — P(A). Montrer que A est inversible

puis que A et B commutent.

> Éléments de correction. Notons P = P(0)JrXQ(X). La condition AB =

P(A) se récrit A(B — Q(A)) = P(0)In : par conséquent, A est inversible

12

I. Polynômes d'endomorphismes

d'inverse

De plus, B = A~1P(A) commute avec A. <\

6.10. Exercice. Soit f G C(E) tel que

Vf = X[{X-\k)\

k=i

où Ai,..., Xp sont des scalaires deux à deux distincts.

1. Montrer qu'il existe une base (#i,..., H2n) de K2n_i[X] telle que

> pour tout k G [1, n], Hk{Xi) = ôk,i et H'k(Xi) = 0 ;

> pour tout k G fn + 1, 2n\, Hk(Xi) = 0 et H'k(\i) = ôk,i-

2. En déduire en fonction des polynômes (iJi,..., i^2n); un expression des

puissances de f'.

t> Eléments de correction.

1. L'application

/ K2n_x[X] -> K2n

\ P h> (P(A1),P'(A1),...,P(Àn),P'(An))

est linéaire et injective (si P est dans son noyau, alors il admet n racines

doubles et est de degré au plus 2n — 1 donc est nul) : c'est donc une

bijection ce qui établit la propriété désirée.

2. Effectuons la division euclidienne de Xm par fif : il existe Q G K[X]

et R G K2n-i[X] tels que Xm = Q./i/ + R. On vérifie rapidement que

pour tout k G [1,71], P(Afe) = A^ et R'(\k) = mX™"1. Ainsi,

n n

k=l k=l

car la différence de ces deux membres définit un polynôme du noyau de

l'application linéaire de la première question. En conclusion,

n n

r = j2wHk(f) + Y,mXT~lHn+k(f).

fc=i fc=i

<

Chapitre II

Sous-espaces stables

Objectifs du chapitre

- Distinguer les restrictions des endomorphismes induits.

- Calculer dans des cas simples les sous-espaces stables.

- Utiliser les espaces cycliques associés à un endomorphismes.

1. Restriction d'un endomorphisme

1.1. Définition. Soit / G C{E,E') et F un sous-espace vectoriel de E.

La restriction de / à F est l'application linéaire f\p : F —> E' définie

par J\f{x) = f(x) pour tout x G F.

1.2. Exemple. La restriction de l'identité de E à un sous-espace F est

appelée l'injection canonique de F dans E.

1.3. Proposition. Soit f G jC(E,Ef) et F un sous-espace vectoriel de E.

Alors

ker/|F = Fnker/, imf]F = f(F).

Démonstration. Il suffit d'appliquer les définitions.

ker/|F = {xeF, /|F(») = 0js}

= {xeF, f(x) = 0E} = FDkerf,

im/|F = {y G E, 3x e F, y = f\F(x)}

= {yeE,3xeF,y = f(x)}^f(F).

14

IL Sous-espaces stables

□

1.4. Corollaire. Soit f un endomorphisme et un entier k G N. Alors,

dim ker fkJrl = dim ker fk + dim im / D ker /.

Démonstration. L'objectif est d'appliquer la formule du rang à la

restriction g = /,ker r/c+i- Remarquons alors que

ker g = ker fk H ker fk+1 = ker fk

par croissance de la suite des noyaux itérés et img = imfk D fk(ker fk+1).

Comme /fe(ker/fe+1) C ker/, im^C im/fcnker/. Montrons l'inclusion

réciproque. Soit y G im fk Hker/'. Par définition, f(y) = 0^ et il existe x G E

tel que y — fk(x) ; par conséquent, fk+1(x) = 0e et donc y G /^(ker fkJrl).

En conclusion, img = im fk D ker /.

La formule du rang donne alors directement

dim ker fk+1 = dim ker fk + dim ker / D im fk.

D

1.5. Remarque. Cette propriété en apparence anodine permet de

retrouver assez facilement (en exploitant la décroissance de la suite des images

itérées) que la suite des « sauts de dimension dans la suite des noyaux »

décroît.

En effet, on sait déjà que la suite des noyaux itérés (ker fk)k d'un

endomorphisme / est croissante pour l'inclusion (en fait strictement croissante

puis stationnaire). On remarque que, pour tout & G N,

ker / n im fk+1 C ker / H im fk,

ce qui entraîne, avec le corollaire précédent que la suite des sauts de

dimension dans la suite des noyaux itérés

(dimker/fc+1 - dim ker fk)k

est décroissante.

1.6. Exemple. Remarquons que dim ker/2 = 2 dim ker/ si, et

seulement si, ker/ C im/. En effet, d'après le corollaire précédent, la

condition dim ker /2 = 2 dim ker / équivaut à dim ker / = dim ker / n im /, soit

encore à

ker / H im / = ker /

et donc à ker / C im /.

2. Sous-espace stable

15

2. Sous-espace stable

2.1. Définition. Soit / un endomorphisme d'un espace vectoriel E. Un

sous-espace vectoriel F de E est stable par / si f(F) C F.

2.2. Exemple. Pour tout endomorphisme /, im/ et ker f (et plus

généralement kerP(/) pour tout P G K[X]) sont stables par /. Au chapitre

suivant, on relie cette propriété avec la propriété de commutation.

2.3. Proposition. Soit F un sous-espace stable par deux endomorphismes f

et g. Alors, F est stable par f + g et f o g.

Démonstration. Pour tout x G F, f{x) G F et g(x) G F donc f(x)+g(x) G

F et f(g(x)) G F. □

2.4. Proposition. Soit f un endomorphisme, g un automorphisme d'un

espace vectoriel E et soit F un sous-espace stable par f. Alors, g (F) est un

sous-espace stable par g o / o g~l.

Démonstration. Pour tout y G g (F), il existe x G F tel que y = g(x). Alors,

f(x) G F et donc g o / o g-\y) = g(f(x)) G g(F). □

2.5. Exemple. Soit p une rotation de M3 d'axe dirigé par le vecteur u et

d'angle 0 et f une isométrie. Alors, la rotation f o p o f"1 a pour axe la

droite dirigée par f(u).

2.6. Remarque. L'intérêt des sous-espaces stables est qu'ils permettent

d'obtenir une première version plus simple d'un endomorphisme : si l'on

dispose d'une décomposition de E en somme directe de sous-espaces stables

par /, alors l'étude de / est équivalente à l'étude des endomorphismes

induits par / sur chacun de ces sous-espaces.

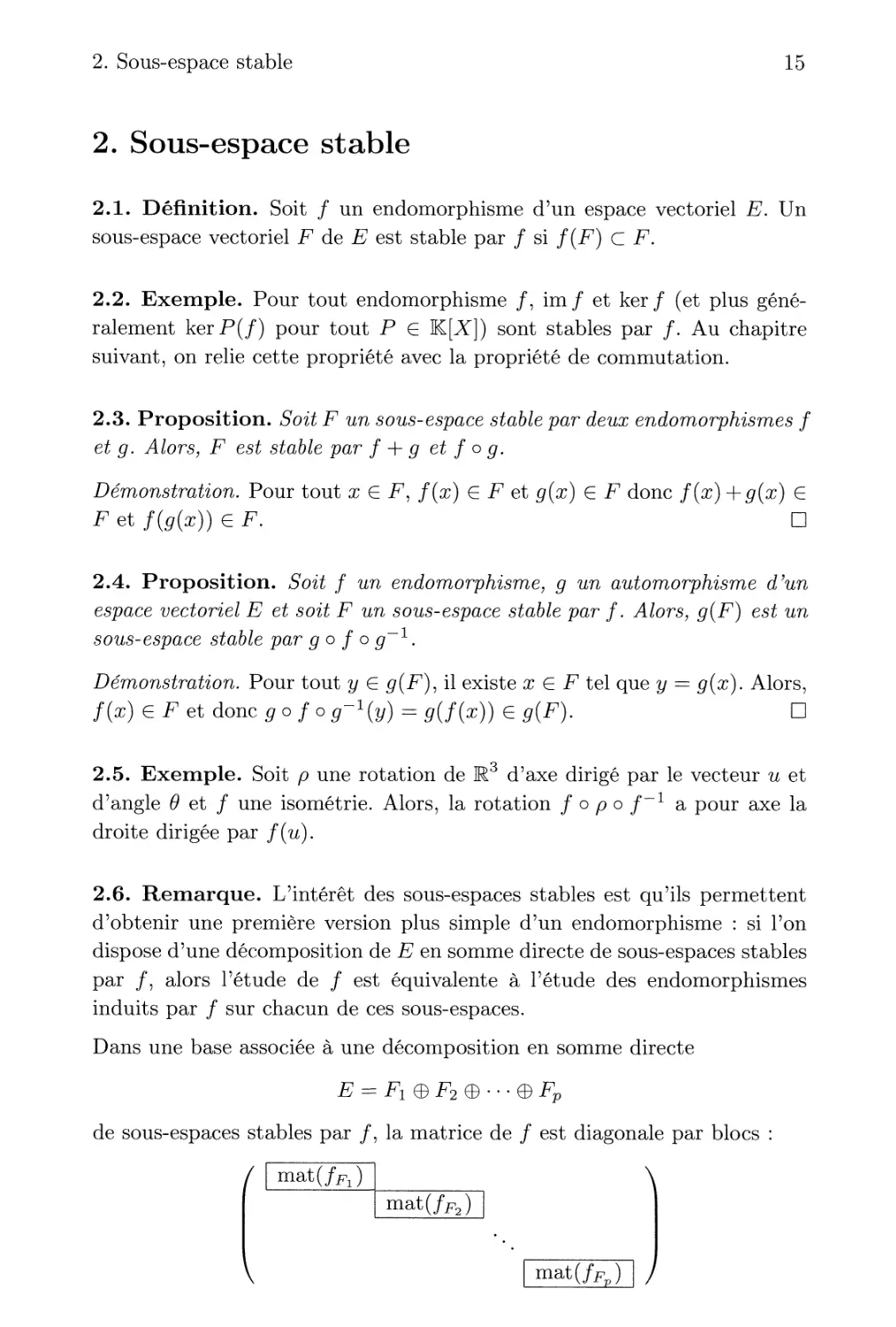

Dans une base associée à une décomposition en somme directe

e = fx e f2 e • • • e fp

de sous-espaces stables par /, la matrice de / est diagonale par blocs :

mat(/Fl)

mat(/FJ |

V | mat(/Fp) 1 /

16

IL Sous-espaces stables

3. Endomorphisme induit sur un sous-espace

stable

3.1. Définition. Si F est un sous-espace stable d'un espace vectoriel E

par un endomorphisme /, alors l'endomorphisme induit par / sur F est

l'endomorphisme fp ' F -> F défini par /f(x) = f(x) pour tout x G F.

3.2. Remarque. Soit / un endomorphisme et F un sous-espace stable

par /. Il ne faut pas confondre la restriction f\F qui est à valeurs dans E

et l'induit fp qui est à valeurs dans F.

3.3. Proposition. Soit f G C(E) et F un sous-espace stable par f. Alors,

le polynôme minimal de Vinduit fp divise le polynôme minimal de f.

Démonstration. Il suffit de remarquer que fif est annulateur de l'induit fpX2

3.4. Proposition. Soit f G C{E). Supposons que E = F.Ç&G avec F et G

deux sous-espaces stables par f. Alors, le polynôme minimal de f est le

PPCM des polynômes minimaux de fp et fc-

Démonstration. > Comme les polynômes fj,fF et \ifG divisent ///, leur PPCM

divise aussi /if.

> Montrons désormais que fjifF V /i/G est annulateur de / (et donc un

multiple de /j,f). Soit x G E, xp G F et xq G G tels que x — xp -f xq-

Alors,

M/f V M/g(/)W = M/f V M/g(/)(sf) + M/f V VfG(f)(xG)

= M/f V///g(/f)(zf) + M/f vM/g(/g)(^g)

= 0f,

car //yF V fifG est annulateur de fp et /^ en tant que multiple de fj,fF

et nfG. D

4. Exemples de sous-espaces stables

Déterminons tous les sous-espaces stables dans quelques cas particuliers.

4.1. Exemple. Tous les sous-espaces sont stables par une homothétie.

4.2. Exemple. Soit p un projecteur (donc la projection sur imp = ker(p —

Id) parallèlement à kerp). Montrons qu'un sous-espace est stable par un

projecteur p si, et seulement si, il est la somme directe d'un sous-espace

de imp et d'un sous-espace de kerp.

5. Sous-espaces cycliques

17

Soit F un sous-espace stable par p. L'endomorphisme pp induit par p sur F

est un projecteur de F ; par conséquent, F est la somme directe du noyau

de pf et de l'image de pf qui sont, respectivement, des sous-espaces de imp

et de ker p.

Réciproquement, la somme directe d'un sous-espace de imp et d'un sous-

espace de kerp est bien un sous-espace stable, car p laisse invariant tous les

éléments de imp.

4.3. Remarque. De même, les sous-espaces stables par une symétrie

vectorielle s sont obtenus comme somme directe d'un sous-espace de ker(s —Id)

et d'un sous-espace de ker (s + Id).

4.4. Exemple. Soit / un endomorphisme de E, nilpotent d'indice n =

dimE (c'est-à-dire tel que fn = 0 et fn~~l ^ 0). Montrons que les sous-

espaces stables sont les ker fk pour k G [l,n]. Il est immédiat que ces

sous-espaces sont stables d'après la proposition précédente.

Soit F un sous-espace stable par / ; l'endomorphisme fp induit par /

sur F est nilpotent. Notons p son indice. On a alors F = ker fF C ker/p.

Or dim ker fp — p (car les noyaux itérés de / forment une suite strictement

croissante jusqu'au rang n) donc dim F ^ p. Mais comme fp est d'indice p,

alors dim F ^ p (même résultat sur la suite des noyaux itérés).

5. Sous-espaces cycliques

Soit / un endomorphisme d'un espace vectoriel E et x G E non nul. Si

deux sous-espaces F\ et F2 sont stables par / et contiennent x, alors leur

intersection est un sous-espace non réduit au vecteur nul (il contient x) et

stable par /.

5.1. Définition. Soit / un endomorphisme d'un espace vectoriel E et x G

E. Le sous-espace cyclique de / associé au vecteur x, est le plus petit

(pour l'inclusion) sous-espace stable par / contenant x. On le note Ef^x

(ou, plus simplement, Ex s'il n'y a aucune ambiguïté sur l'endomorphisme

considéré).

D'après les remarques précédents la définition, si un sous-espace F de E

stable par / contient x, alors EfyX C F.

18

IL Sous-espaces stables

5.2. Proposition. Soit f un endomorphisme d'un espace vectoriel E

et x G E. Le sous-espace cyclique de f associé à x est le sous-espace

engendré par la famille (fk(x))ken-

Démonstration. Comme vect(fk(x))ken est un sous-espace de E contenant

x et stable par /, alors

EfiX C vect(fk(x))keN.

Réciproquement, pour tout k G N, fk(x) G EfyX (par récurrence, car x G

Ef%x et EfiX est stable par /). D'où E^x = vect(fk(x))keN- D

5.3. Remarque. Il est facile de montrer que la dimension du sous-espace

cyclique Ef^x est en fait le degré du polynôme minimal local de / en x,

noté fifjX et que si cette dimension est notée n, alors la famille

{x,f{x),...Jn~l(x))

est une base de EfjX.

6. Commentaires et développements

6.1. Soit F C E un sous-espace stable pour / G C(E) et fp

l'endomorphisme induit par / sur F. Aux côtés de l'endomorphisme fp, il existe un

autre endomorphisme induit apparaissant dans ce cadre : l'endomorphisme

fp/F> induit par / sur le quotient de E par F

f E/F -> E/F

JE/F '

\El-:

f(x)

L'endomorphisme fp/F recèle, tout comme fp, de renseignements

intéressants sur le couple (/, F). Par exemple, det / = det fp det Je/F- La matrice

M de / dans une base (ei,..., ep, ep+i,..., ep+q) adaptée à une

décomposition E — F 0 G est de la forme f ~ ) ; la matrice de fp/F dans la

base (ep+i,..., ep+q) de E/F est la matrice C qui apparaît en bas à droite

dans la matrice M.

6.2. La situation précédente se généralise comme suit. Un drapeau Q) de

E est une suite croissante de sous-espaces vectoriels de F, soit

® : {0} C Fx C F2 C • • • C Fp C E.

Un drapeau complet de E est un drapeau formé de dim E +1 sous-espaces

Fi vérifiant dim Fi — i. Un drapeau est /-stable si tous ses sous-espaces

sont stables par /.

6. Commentaires et développements

19

Un endomorphisme / est ainsi trigonalisable si, et seulement si, il laisse

stable un drapeau complet ; une matrice est triangulaire en blocs si, et

seulement si, elle laisse stable un drapeau ayant au moins un sous-espace

non trivial.

À un drapeau $) dans E, on associe un espace vectoriel Grad(^, E) (de

même dimension que E), appelé le gradué associé, défini par

Grad(^,£) = Fx 0 (F2/F1) 0 • • • 0 (Fp/Fp^) 0 (E/Fp).

Si le drapeau Q) est /-stable, il s'induit naturellement sur le gradué associé

un endomorphisme

Grad(/) : Grad(^,£) -> Grad(^,£),

qui est la « somme directe » des endomorphismes induits successivement

dans les quotients, soit

Grad(/) - fFl 0 (fF2)F2/Fl 0 • • • 0 fE/Fp-

On a encore det/ = detGrad(/), trGrad(/) = tr/, et plus généralement

l'égalité des polynômes caractéristiques respectifs.

Matriciellement, l'endomorphisme Grad(/) se pense dans une base

convenable comme la matrice diagonale en blocs sous-jacente à une matrice

triangulaire en blocs. Il résume en lui à la fois l'induit sur un sous-espace et

l'induit sur le quotient.

On peut vérifier que si / est diagonalisable, alors Grad(/) l'est également.

6.3. On verra ultérieurement qu'un endomorphisme / cyclique (voir le

chapitre VI pour la définition) admet un nombre fini de sous-espaces stables.

Quand K = C, ces sous-espaces forment un drapeau complet si, et

seulement si, l'algèbre C[/] est locale.

L'endomorphisme gradué associé Grad(/) est dans ce cas une homothétie,

puisque le drapeau s'identifie alors à la suite des noyaux itérés définis par

l'unique valeur propre À :

{0} C ker(/ - AIds) C ker(/ - Ald^)2 C ... C ker(/ - Àld^'-1 C E.

Un endomorphisme n'a pour seuls sous-espaces stables que les deux sous-

espaces triviaux si, et seulement si, son polynôme caractéristique est

irréductible.

6.4. Un sous-espace stable n'admet par en général de supplémentaire

stable (prendre par exemple le bloc de Jordan Jn). Les endomorphismes

qui vérifient que leurs sous-espaces stables ont des supplémentaires stables

s'appellent les endomorphismes semi-simples. Sur C, cela équivaut à dire

20

IL Sous-espaces stables

que l'endomorphisme est diagonalisable. Les endomorphismes semi-simples

réels sont les endomorphismes dont le complexiflé est diagonalisable. Une

matrice antisymétrique réelle est semi-simple.

Dans le cas général, un endomorphisme est semi-simple si, et seulement

si, son polynôme minimal est sans facteur carré1. Cela revient à dire que

l'algèbre K[f] est réduite (sans éléments nilpotents non nuls) ou encore si

elle est produit de corps.

Le gradué associé à un endomorphisme semi-simple relativement à un

drapeau stable est à son tour semi-simple.

6.5. Si F C E est un sous-espace stable par /, l'orthogonal F^ de F dans

l'espace dual E* est stable par l'endomorphisme tf : E* —> E* transposé

de /. La recherche des hyperplans stables par / se ramène en particulier à

la recherche des droites stables par tf.

Une question naturelle vient maintenant à l'esprit, au vu du commentaire

par lequel a débuté cette section : quel est l'endomorphisme %fE* /F± induit

par tf dans le quotient E* /F1- ? On a tout simplement

fE*/F± = fF,

une fois que l'on a identifié E*/F± avec le dual F* de F, comme il résulte

naturellement de l'écriture

F1- <-» E* -^ F\

où pf est l'endomorphisme de restriction à F.

6.6. Un exercice amusant ici est le suivant, lequel est un cas particulier de

ce qui précède : montrer que si le polynôme minimal de / est irréductible,

alors tout sous-espace stable par / admet un supplémentaire stable. L'idée

c'est de munir E d'une structure d'espace vectoriel E^ sur le corps F = K[u],

de caractériser le sous-espaces stables par / comme étant les sous-espaces

du F-espace vectoriel E^ et d'appliquer le fait élémentaire que tout sous-

espace vectoriel d'un espace vectoriel admet un supplémentaire.

7. Exercices

7.1. Exercice. Soit f G C(E). Montrer que ker/ et im/ sont

supplémentaires dans E si, et seulement si, ker / = ker f2.

1. La notion de semi-simplicité se comporte, de ce fait, bien par rapport aux

extensions de corps, puisque le polynôme minimal ne dépend pas du corps de base.

7. Exercices

21

> Éléments de correction. D'après le corollaire II-1.4, la condition ker/ =

ker f2 équivaut à ker /nim / = {0#}. D'après la formule du rang, cette

dernière propriété (ker / et im / en somme directe) se récrit encore en ker / 0

im / = E. <

7.2. Exercice. Soit E un espace vectoriel de dimension n et f G C(E)

nilpotent.

1. Montrer que l'indice de nilpotence de f est n si, et seulement si,

dim-ker / = 1.

2. Montrer que, si Vindice de nilpotence de f est n — 1, alors dimker / H

im/ = l.

> Éléments de correction.

1. (=>) La suite (ker fk)k est strictement croissante pour k G [0,n] et

dimker/77, — dimE = n. Par conséquent, pour tout k G [0, n], on a

dim ker/^ = k.

(<=) La suite (dimker//c+1 — dimker/^)^ est décroissante de premier

terme 1. Ainsi, si un noyau itéré ker fk est de dimension n, alors k ^ n.

Comme un indice de nilpotence est inférieur ou égal à n, l'indice de

nilpotence de / est n.

2. > Remarquons tout d'abord que dimker / > 2 d'après la première

question donc dim im / $J n — 2.

> L'endomorphisme induit /im/ est nilpotent d'indice n — 2, car /

est d'indice de nilpotence n — 1. Ainsi, dimim/ = n — 2 et d'après

la question précédente, dim ker g = 1. Or, ker# = ker/ n im/ d'où

dim ker / D im / = 1.

La réciproque à cette deuxième question est fausse comme on peut le

voir avec la matrice suivante d'indice de nilpotence 2

/ 0 1 0 0 \

0 0 0 0

0 0 0 0

\ 0 0 0 0 /

<

7.3. Exercice. Déterminer les sous-espaces stables de rendomorphisme

Mn(K) -+ Mn(K)

M h-> *M

D> Eléments de correction. L'endomorphisme considéré est l'une des deux

symétries vectorielles associées à la décomposition M.n(K) = Sn(K) 0

22

IL Sous-espaces stables

An(K) (l'autre étant M i-> —lM). Les sous-espaces stables sont donc les

sommes d'un sous-espace de <Sn(K) et d'un sous-espace de An(K) (remarque

II-4.3). <

7.4. Exercice. Soit A G A//n(K) non nulle. Déterminer les sous-espaces

stables de Vendomorphisme

Mn(K) -> Mn(K)

M h-> tr(AM)In

ï> Eléments de correction. > Remarquons tout d'abord que tous les sous-

espaces de Mn(K) contenant In sont stables.

> Soit F un sous-espace de Mn(K) ne contenant pas ïn. Le sous-espace F

est stable par cet endomorphisme si, et seulement si, pour tout M G F,

tr(AM) = 0, c'est-à-dire si F est inclus dans l'hyperplan

H = {M G Mn(K), ti(AM) = 0}.

En conclusion, les seuls sous-espaces stables sont ceux qui contiennent In

ou qui sont inclus dans l'hyperplan H.

L'endomorphisme considéré est de rang 1 (on peut même vérifier que sa

trace est égale à trA). De manière générale, un sous-espace F est stable

par un endomorphisme f de rang 1 si, et seulement si, im/cF ou (non

exclusif) F C ker/. <\

7.5. Exercice. Soit f un endomorphisme. Montrer que si ker/ admet un

supplémentaire S stable par f, alors S = im/.

t> Eléments de correction. Soit S un supplémentaire de ker / stable par /.

Comme ker/ D S = {0^;}, / réalise un isomorphisme de S dans S. Ainsi,

S = /(S)cim/.

Par ailleurs, la formule du rang donne

dim im / = dim E — dim ker / = dim 5.

En conclusion, S = im /. <

7.6. Exercice. Déterminer les endomorphismes de Kn laissant stables

chacun des axes de coordonnées et la droite engendrée par le vecteur (1,1,...,1).

> Éléments de correction. Notons ei, e2, ..., en la base canonique de Kn

et / un endomorphisme de Kn qui vérifie les conditions de l'énoncé. Par

définition, il existe des scalaires Ai, ..., Àn, À G K tels que /(e&) = Àe^

pour tout k G [1, n] et f(e\ + ... + en) = A(ei -f ... + en). Par linéarité,

7. Exercices

23

on a

Àiei + ... + Anen = A(ei + ... + en)

et donc Ai = ... = Àn = À. En conclusion, / est une homothétie.

Réciproquement, il est évident que les homothéties vérifient bien les conditions de

l'énoncé. <\

7.7. Exercice. Montrer qu'un endomorphisme f G C(E) est une

homothétie si, et seulement si, pour tout x G E, dim Ef^x = 1. '

D> Eléments de correction. Remarquons que la condition dim EfiX = 1

équivaut à (x,f(x)) liée et l'on est ramené à un problème classique d'algèbre

linéaire. Comme ce résultat sera utilisé à plusieurs reprises, détaillons-le.

Pour tout x G E, il existe Xx G K tel que f(x) = Xxx.

Soit x et y deux vecteurs de E. Alors, par linéarité de /,

Xx.x + Xy.y = Xx+y.(x + y).

- Si vect(x) = vect(y) =^ {0^;}, alors x et y sont colinéaires non nuls et

XX = Xy.

- Si vect(x) et vect(y) sont en somme directe, alors, par unicité de

l'écriture,

Ax = Ax-\-y — Ay.

<

7.8. Exercice. Déterminer les endomorphismes pour lesquels tous les sous-

espaces sont stables.

D> Éléments de correction. Si tous les sous-espaces sont stables pour un

endomorphisme /, alors toutes les droites sont stables et donc / est une

homothétie (comme on l'a redémontré dans l'exercice précédent).

Réciproquement, tous les sous-espaces sont stables par une homothétie. <

7.9. Exercice. Soit D une droite vectorielle de R3. Déterminer les

endomorphismes de R laissant stables tous les plans de R contenant D.

> Éléments de correction. Considérons e\ un vecteur directeur de D et

complétons-le en une base (61,62,63). Soit / un endomorphisme laissant

stable tous les plans de R3 contenant D.

Dans un premier temps, / laisse stable les plans vect(ei, 62) et vect(ei, 63)

donc laisse stable D qui est leur intersection. La matrice de / dans cette

24

IL Sous-espaces stables

base est donc de la forme

Ensuite, / laisse stable le plan vect(ei, e2) : la matrice est donc de la forme

En procédant de même avec le plan vect(ei, 63), on obtient la forme

Enfin, / laisse stable le plan vect(ei, e2 + 63) et, avec nos notations, f(e2 +

63) = (a + 7)ei + (3e2 + £e3, d'où (3 = ô.

Réciproquement, si un endomorphisme / admet dans la base (ei, e2.es)

une matrice de la forme

À a 7

0/3 0

0 0/3

alors il laisse stable tous les plans contenant D car, pour tous a, b G M,

f(ae2 + 6e3) = (aa + bj)ei + /3(ae2 + be3).

Remarquons qu'avec la notion d'espace vectoriel quotient, on aurait

simplement dit que Vendomorphisme de l'espace quotient R /D associé à f est

une homothétie. <

7.10. Exercice. Soit f G £(]R3) nilpotent d'ordre 2. Montrer les sous-

espaces de dimension 2 stables par f sont ceux qui contiennent im/.

D> Éléments de correction. t> Si un sous-espace F contient im/, alors il

contient f(F) : par conséquent, F est stable.

> Soit F un plan de M3 stable par F. Remarquons que la condition f2 =

Û£(R3) entraîne im/ C ker/ et donc, grâce à la formule du rang dimim/ =

1 et dimker/ = 2.

- Si F = ker /, alors im / C ker / = F.

- Sinon, il existe x G F tel que f(x) ^ 0K3. Comme im/ est une droite,

im/ = vect/(x)c/(F)cF

Dans les deux cas, F contient l'image de /. <

Chapitre III

Commutation

Objectifs du chapitre

- Calculer le commutant de quelques endomorphismes simples.

- Comprendre les sous-espaces stables fournis par une relation de

commutation.

- Savoir calculer avec l'endomorphisme adf associé à un endomorphisme.

1. Définitions

1.1. Définition. > Deux endomorphismes f et g d'un même espace

vectoriel E commutent sifog = gof.

> Soit / un endomorphisme d'un espace vectoriel E. Le commutant de /

est l'ensemble, noté C(/), des endomorphismes de E qui commutent avec /.

> Soit / un endomorphisme d'un espace vectoriel E. Le bicommutant de /

est l'ensemble des endomorphismes qui commutent avec tous les éléments

de C(f).

1.2. Remarque. Encore une fois, ces notions s'étendent pour définir le

commutant et le bicommutant d'une matrice.

1.3. Proposition. Le commutant C(f) d'un endomorphisme f d'un espace

vectoriel E est une sous-algèbre de C(E).

Démonstration. Remarquons tout de suite que C(f) C C(E) et que Id G

C(f). Pour tous g,he C(f) et tout AgKj + A/iG C(f) et g o h G C(f)

26

III. Commutation

car

(g + \h)of = gof + \hof = fog + \foh

= fo(g + \h).

(goh)of = go(hof)=gofoh

= (g°f)°h = fogoh.

D

1.4. Proposition. Soit f un endomorphisme de E et g un automorphisme

de E. Alors,

C(gofo (T1) = sCCOjT1 = {gohog-\ he C(f)}.

Démonstration. Un endomorphisme h G C{E) appartient au commutant

C(g o f o g~l) si, et seulement si,

hogo f og-1 = go f og"1 oh,

soit

g-1 o h o g o f = f o g'1 o h o g,

c'est-à-dire g"1 o ho g appartient au commutant de /. D

Un des intérêts de la propriété de commutation est qu'elle permet de

dégager des sous-espaces stables assez facilement.

1.5. Proposition. Soit f et g deux endomorphismes de E tels que f o g =

g o f. Alors, le noyau et l'image de g sont des sous-espaces stables par f.

Démonstration. > Si x G ker#, alors g(f(x)) — f(g(x)) = /(0#) = 0^,

d'où f(x) G kerg.

D> Si y G img, alors il existe x G E tel que y = g(x). Par conséquent,

f (y) = f (g(x)) =g(f(x)) G im g. D

On a déjà utilisé cette propriété pour g G K[/].

1.6. Proposition. Les seuls endomorphismes qui commutent avec tous les

automorphismes sont les homothéties.

En théorie des groupes, on dit que le centre de GL(i?) est {Aid, A G K*}.

Démonstration. Soit / un endomorphisme qui commute avec tous les

automorphismes. Pour tout x G E, considérons F un supplémentaire de vect(x)

dans E et s la symétrie vectorielle par rapport à vect(x) parallèlement à F.

2. Calculs de commutants

27

Comme / commute avec s donc avec s — Id, / laisse stable ker(s — Id) =

vect(x). Ainsi, pour tout x G E, la famille (#, /(#)) est liée, donc / est une

homothétie. □

2. Calculs de commutants

2.1. Exemple. Déterminons l'ensemble des matrices qui commutent avec

la matrice D = diag(l, 2,..., ri).

t> Si M = {Triij)ij commute avec 12, alors en calculant les produits

matriciels, on obtient que, pour tout (i, j), irriij = jrriij. Par conséquent, pour

tout i ^ j, ra^j = 0 : la matrice M est diagonale. Réciproquement, les

matrices diagonales commutent avec D.

> On peut aborder différemment le problème en remarquant que si M

commute avec D alors M laisse stable tous les sous-espaces ker(D — kln)

avec k G [l,n] donc est diagonale.

2.2. Exemple. Déterminons l'ensemble des matrices qui commutent avec

la matrice

/ 0 1 0 ... 0 \

Jn

V o

0

1

0/

Considérons M = (mij)ij qui commute avec Jn et écrivons les coefficients

des matrices MJn et JnM

Ainsi,

M =

0 si j = 1

rriij-i sinon.

/ mi,i mi,2 mi>3

0

V 0

[JnM]id =

0 si z = n

rrii+ij sinon.

miin \

'• mi>3

0 raM /

Par conséquent, le commutant de Jn est l'algèbre K[Jn] des polynômes

en Jn.

28

III. Commutation

2.3. Remarque. Ce dernier exemple, où le commutant ne contient que des

polynômes en la matrice, est en fait assez générique et nous l'étudierons

extensivement au chapitre VI.

3. Endomorphisme adf

Introduisons ici un exemple d'endomorphisme qui nous servira tout au long

de cet ouvrage.

3.1. Définition. Soit / G C(E). L'endomorphisme adf est défini par

adf :

C(E) -+ C(E)

g »-> f°g-g°f

3.2. Remarques. > Cet endomorphisme nous sert essentiellement à

mesurer le défaut de commutativité. La première remarque dans ce sens est

que le commutant de / est C(f) = ker adf.

> L'application

ad.(L(E) -> £(£(£))

{ f *-> adf

s'appelle représentation adjointe de C{E). Elle vérifie, en plus de la

propriété de linéarité,

adf0g-g0f — adf o adg — adg o adf,

pour tous /, g G C{E).

Calculons les puissances de l'endomorphisme adf.

3.3. Proposition. Pour tout m G N et tous f, g G C{E),

m / \

a^(5) = ^(7J(~1)fe/m~fe°50/fc-

On peut bien entendu établir cette formule par récurrence sur m G N, mais

il est plus raisonnable d'exploiter la structure d'anneau de C(E).

Démonstration. Les endomorphismes G f : g i-> / o g et Df : g H> g o f

commutent, on peut donc appliquer la formule du binôme de Newton pour

calculer les puissances (pour la composition) de adf — Gf — Df et obtenir

le résultat désiré. □

4. Commentaires et développements

29

3.4. Corollaire. Si f est un endomorphisme nilpotent d'indice p, alors adf

est nilpotent d'indice 2p — 1.

Démonstration. > Commençons par remarquer que la formule précédente

avec m = 2p— 1 donne l'endomorphisme nul puisque le terme fm~kogo fk

est nul pour k > p et pour m — k ^ p (c'est-à-dire k ^ p — 1).

> Par ailleurs, pour tout g G £>{E),

adf-2(g) = (-ir-1r-1ogofP-\

De plus, il existe x G E tel que fp~1(x) ■=£ 0^; et g un endomorphisme tel

que g(fp~~1(x)) = x. Avec ces choix, adf~ (g)(x) ^ 0^, donc adf~ n'est

pas l'endomorphisme nul.

En conclusion, l'indice de nilpotence est 2p — 1. □

4. Commentaires et développements

4.1. Le chapitre de la réduction des endomorphismes consiste comme

rappelé dans l'introduction en l'étude de la relation de similitude. Ce chapitre

est l'examen d'une relation d'équivalence définie par l'action du groupe

linéaire GL(E) sur C(E) par conjugaison. Matriciellement, cela revient à

examiner les classes de similitude de matrices, une telle classe étant «

l'orbite » Ûm d'une matrice M sous « l'action » du groupe linéaire GLn(K)

ÛM = {PMP-\ P G GLn(K))}.

Or, on sait que, dans l'étude d'une action de groupe, il y a d'un côté les

orbites, et de l'autre les stabilisateurs. Plus précisément, si l'on pose

Stab(M) = {P G GLn(K), PMP'1 = M},

on a une bijection canonique entre les classes (à gauche) de GLn(K) modulo

Stab(M) et l'orbite ÛM,

GLn(K)/Stab(M) ^ 0(M).

Les stabilisateurs sont des sous-groupes de GLn(K), et il est clair que les

orbites de deux matrices conjuguées (entendre par là, semblables) sont

conjugués, c'est-à-dire

Stab(P0MP_!) = P0 Stab(M) P^1.

Le sous-groupe Stab(M) de GLn(K) coïncide avec le groupe des éléments

inversibles de l'algèbre ^(M) des matrices commutant avec M. Certains

auteurs notent alors 3(M) l'algèbre ^(M) et Z(M) le groupe Stab(M) de

ses éléments inversibles. Nous ne le ferons pas.

30

III. Commutation

4.2. L'algèbre associative ^(M) est plus difficile à étudier que l'algèbre

K[M], ne serait-ce que parce que la première n'est pas commutative alors

que la seconde l'est. Ces deux sous-algèbres coïncident pourtant générique-

ment ; plus précisément, elles sont égales si, et seulement si, la matrice M

est semblable à une matrice compagnon... Lorsque M est, par exemple,

diagonale, il est facile de voir que ^(M) est un produit d'algèbres de matrices,

en l'occurrence l'algèbre des matrices diagonales en blocs de tailles &i,...,

fe/, avec fci H h ki = n (laquelle est de dimension k\-\ \-kf). On voit

déjà ici deux faits, d'autant plus intéressants à relever qu'ils sont valables

pour toute matrice M, diagonale, diagonalisable ou pas : le centre de

l'algèbre ^(M) est réduit à K[M] et la codimension de ^(M) dans Mn(K)

est paire !

4.3. Si M G .A/fn(K), le sous-espace vectoriel ^(M) apparaît comme le

noyau de l'endomorphisme adw De son côté, l'image de adj\4 a une

signification géométrique inattendue : il donne dans le cas réel la direction de

l'espace (affine) tangent en M à l'orbite Û(M), qui s'avère ainsi être une

sous-variété de Mn(R) de dimension paire. L'application linéaire

ad: Mn(K)-ï C(Mn(K))

s'appelle la représentation adjointe de Mn(K) ; elle vérifie

ad[M,N) — adM o adjy — ad^ ° adj\4-

Son noyau est réduit aux matrices scalaires ; quant à son image, on se

contentera de dire qu'elle est formée de dérivations1 (de traces nulles) de

l'algèbre Mn(K).

5. Exercices

5.1. Exercice. Déterminer une condition nécessaire et suffisante pour

qu Jun projecteur p commute avec un endomorphisme f fixé.

\> Eléments de correction. Soit p le projecteur sur F parallèlement à G.

Montrons que p commute avec / si, et seulement si, les sous-espaces kerp

et ker(p — Id) sont stables par /.

> Si p commute avec /, alors F — kei(p — Id) et G = kerp sont stables

par /.

o Réciproquement, si F = ker(p — Id) = imp et G = kerp sont stables

1. Une dérivation de l'algèbre A^n(K) est, par définition, un endomorphisme 0 de

Mn(K) vérifiant 6(XY) = 6{X)Y + X0(Y).

5. Exercices

31

par /, alors pour tout xF G F et tout xq G G,

fop(xF + xg) = f(xF)

p o f(XF + o^) = p{f{xF) -f /(xG)) = /(xF).

donc / op = po /.

<

5.2. Exercice. Montrer que si deux endomorphismes f et g vérifient f +

g = f o g, alors ils commutent.

> Eléments de correction. Remarquons que (/ — Id)o(g — Id) = Id, donc les

endomorphismes / — Id et g — Id sont inverses. Ainsi, (g — Id) o (/ — Id) = Id

et par conséquent,

/O0=(/-Id)o(0-Id)+0 + /-Id

= (0-Id)o(/-Id)+0 + /-Id

= 9°f-

<

5.3. Exercice. Déterminer la dimension du commutant d'une matrice

diagonale.

> Eléments de correction. Notons D la matrice diagonale et soit Ai, A2,

..., Ar les valeurs distinctes sur la diagonale et d\, d2, ..., dr le nombre

de fois où chacune d'elles apparaît. On peut, quitte à utiliser la

proposition III-1.4, supposer la matrice D = diag(AiI^1,..., ArI^r). Une matrice M

qui commute avec D laisse stable les sous-espaces ker(D — \iln) donc est

diagonale par blocs avec la même structure que D.

Réciproquement, une telle matrice commute bien avec D (dont la restriction

à chacun des sous-espaces est scalaire).

En conclusion, la dimension du commutant de D est

i=l

5.4. Exercice. Déterminer le commutant de la matrice diagonale par blocs

\

(

1

0 1

0 0

V

0 1 0

0 0 1

000

32

III. Commutation

> Éléments de correction. Considérons une matrice M du commutant que

l'on écrit en blocs

Alors, la commutation équivaut aux conditions AJ2 — J2A DJ3 = J3D,

CJ2 = J3C et BJ3 = J2B. Les deux premières conditions se résolvent avec

l'exemple III-2.2. On exploite les deux autres « à la main » et l'on obtient

qu'une matrice du commutant est de la forme

a

0

e

0

^ 0

b

a

~T

e

0

0

0

9

0

0

c

0

h

9

0

d

c

i

h

9

avec a, 6, c, d, e, /, g, h et i G K.

La dimension du commutant est donc 9.

Il existe un résultat général exprimant la dimension du commutant d'une

matrice nilpotente comme la somme des carrés des longueurs des colonnes

de son tableau de Young : ici, 22 + 22-fl2 = 9. <

5.5. Exercice. Soit A G .M2Q&) une matrice non scalaire. Montrer que le

commutant de A est K[Â\.

> Eléments de correction. Comme A n'est pas scalaire, il existe un

vecteur X G A42,i(IK) tel que la famille (X,AX) est libre donc une base

deA42,i(K).

Soit M une matrice qui commute avec A. Posons a, j5 G K tels que

MX = aX + f3 AX = (aln + pA)X.

Alors,

MAX = AMX = A{aln + j3A)X - (aln + f3A)AX.

Ainsi, les endomorphismes associés aux matrices M et {aln-\-j3A) coïncident

sur une base donc les matrices sont égales : M = aln + fi A G K[A}.

L'inclusion K[A] C C(A) est évidente, d'où l'égalité.

Ce résultat indique seulement que les matrices de M.2^) non scalaires sont

cycliques. On étudie cette notion au chapitre VI. <

5.6. Exercice. Déterminer l'ensemble des matrices qui commutent avec

toutes les matrices triangulaires supérieures strictes.

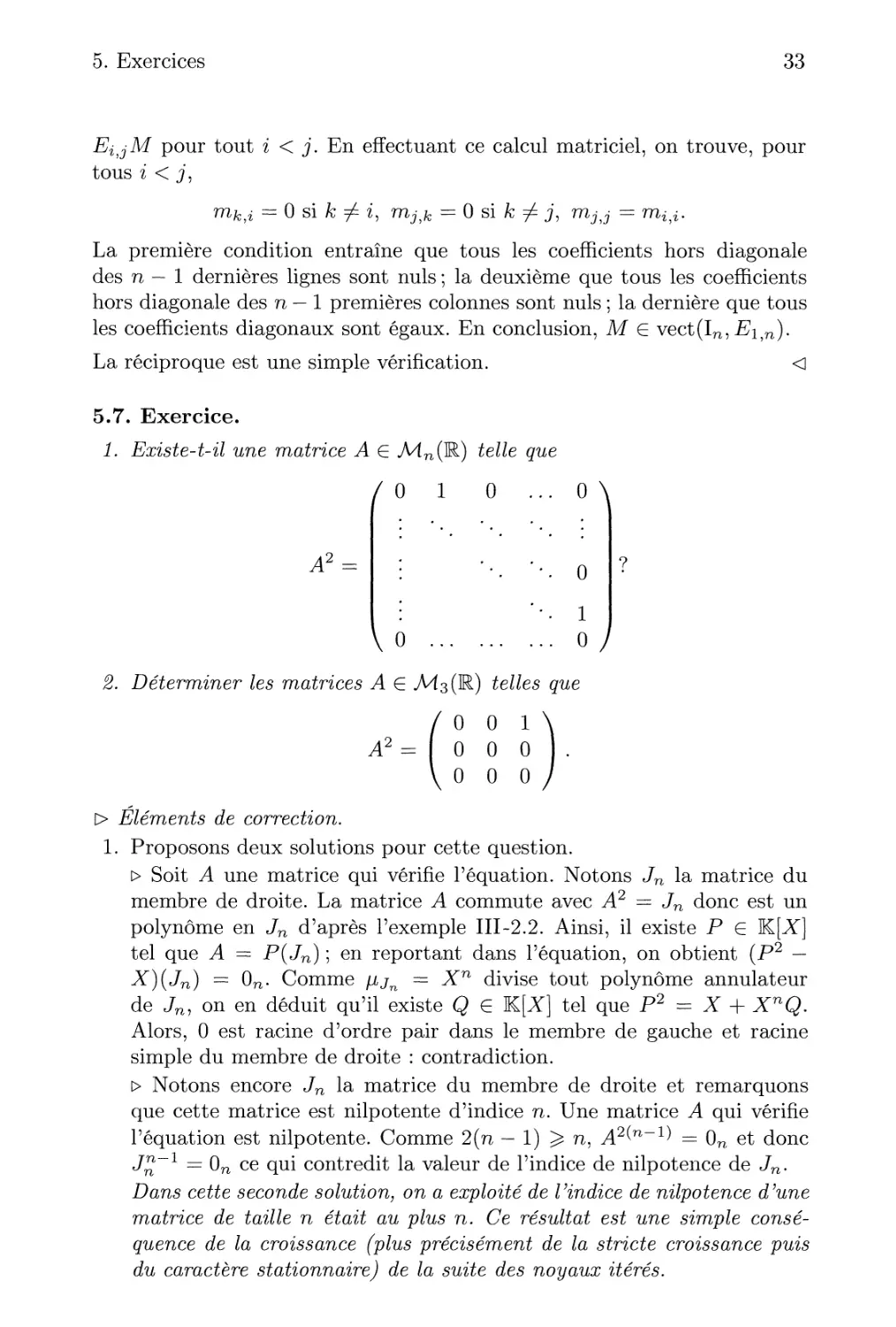

O Éléments de correction. Une matrice M = (rriij) commute avec toutes

les matrices triangulaires supérieures strictes si, et seulement si, MEij =

5. Exercices

33

EijM pour tout i < j. En effectuant ce calcul matriciel, on trouve, pour

tous i < j,

rrik,i = 0 si k ^ i, ra^fc = 0 si /c / j, raJ;J- = ra^.

La première condition entraîne que tous les coefficients hors diagonale

des n — 1 dernières lignes sont nuls ; la deuxième que tous les coefficients

hors diagonale des n — 1 premières colonnes sont nuls ; la dernière que tous

les coefficients diagonaux sont égaux. En conclusion, M G vect(In, £i,n).

La réciproque est une simple vérification. <

5.7. Exercice.

1. Existe-t-il une matrice A G Mn(ï

/ o i

Az =

telle que

0 ... 0 \

0

\0

1

0/

2. Déterminer les matrices A G Ms(R) telles que

A2

t> Eléments de correction.

1. Proposons deux solutions pour cette question.

> Soit A une matrice qui vérifie l'équation. Notons Jn la matrice du

membre de droite. La matrice A commute avec A2 = Jn donc est un

polynôme en Jn d'après l'exemple III-2.2. Ainsi, il existe P G ~K[X]

tel que A = P(Jn)\ en reportant dans l'équation, on obtient (P2 —

X)(Jn) = 0n. Comme jijn = Xn divise tout polynôme annulateur

de Jnj on en déduit qu'il existe Q G K[X] tel que P2 = X + XnQ.

Alors, 0 est racine d'ordre pair dans le membre de gauche et racine

simple du membre de droite : contradiction.

> Notons encore Jn la matrice du membre de droite et remarquons

que cette matrice est nilpotente d'indice n. Une matrice A qui vérifie

l'équation est nilpotente. Comme 2(n — 1) ^ n, .A2(n_1) = 0n et donc

J™-1 = 0n ce qui contredit la valeur de l'indice de nilpotence de Jn.

Dans cette seconde solution, on a exploité de Vindice de nilpotence d'une

matrice de taille n était au plus n. Ce résultat est une simple

conséquence de la croissance (plus précisément de la stricte croissance puis

du caractère stationnaire) de la suite des noyaux itérés.

34

III. Commutation

Soit A une matrice qui vérifie l'équation. Comme A commute avec A2,

on en déduit que A est de la forme

A

0

0

a

7

0

P

ô

A

Une fois cette simplification obtenue, on peut reporter dans l'équation

et trouver X = j = 0 et aô = 1.

Réciproquement, pour tout a ^ 0 et tout /3, les matrices

0

0

0

a

0

0

P

1

a

0

vérifient l'équation.

5.8. Exercice. Soit A, B G Mn(R) telles que AB — BA soit de rang 1.

Montrer que B laisse stable k.ei A ou imA

\> Éléments de correction. Remarquons tout d'abord que la droite im(AB—

BA) est incluse dans imA ou en somme directe avec imA

> Si im(AB — BA) c imA, alors, pour tout vecteur X G Mnji(K), il

existe Y G Mn,i(K) tel que ABX ~ BAX = AY^ donc BAX e [mA :

l'image de A est stable par B.

> Si im(AB — BA) fl im^ = {0n5i}, alors, pour tout vecteur X G kerA,

ABX = ABX - BAX G im^ n im(AB ~ BA).

Ainsi, ABX = 0n?i et BX G ker^4 : le noyau de A est stable par B. <

5.9. Exercice. Soit G un sous-groupe fini de GL(E) et F un sous-espace

vectoriel de E stable par tous les éléments de G- Montrer qu'il existe un

supplémentaire de F dans E stable par tous les éléments de G (théorème

de Maschke).

Indication : on pourra, pour un supplémentaire G de F, introduire le

projecteur p sur F parallèlement à G puis le projecteur

]yi geG

> Eléments de correction. Soit G un supplémentaire quelconque de F (qui

existe car E est de dimension finie) et p le projecteur sur F parallèlement

à G. Posons q comme dans l'indication.

5. Exercices

35

> Soit g G G- Remarquons que g (F) — F donc, pour tout x G F, il existe y G

F tel que x = g (y). Alors, gop°g~l(x) = gop(y) = g(y) = x, car F = imp.

Ainsi, tous les éléments de F sont fixes par g ° p ° g~l donc par g; par

conséquent, F C im(g).

Par ailleurs, pour tout x G F, il existe x' G F et x" G G tels que g-1(x) =

x' + x", donc g o p o g~'1(x) = g o p[xf + x") — g(x/) G #(F) = F. En

conclusion, imçcF, d'où imç = F.

> De plus, q est un projecteur. En effet, pour tout x e E, q(x) e F et l'on a

vu que les éléments de F sont fixes par q donc q2(x) = q{x). Ainsi, q2 = q.

> Pour tout h G G->

hoq= -L- Y^ho9°P°g~1

'^' geQ

= -—- 2_] k°P° k~X o h en posant k = h o g

= q o h.

Ainsi, q commute avec tous les éléments de G-

En conclusion, le noyau de q est un supplémentaire de F = img (car q est

un projecteur), stable par tous les éléments de G (d'après la propriété de

commutation). <

5.10. Exercice. Soit X, Y et H G A^C) non nulles telles que

HX-XH = 2X

HY ~YH = -2Y

XY-YX = H

1. Montrer que XetY sont nilpotentes (donc de rang 1).

Indication : on pourra vérifier que trX = trX2 = 0.

2. Vérifier que si kerX = ker Y, alors il existe À G C tel que X = XY ; en

déduire une contradiction.

3. Montrer qu'il existe une même matrice P G GL2(C) telle que

36

III. Commutation

> Éléments de correction.

1. Comme 2X = HX - Xff, 2trX = tr(HX) - tr(XH) = 0 ; de plus,

4X2 = HX2-X2H et donc trX2 = 0. On a, de même, tr Xk = 0 pour

tout k G N*.

Reste à voir que cela entraîne que la matrice X est nilpotente ; ce

résultat sera évident avec le théorème de Cayley & Hamilton mais nous

en proposons ici une démonstration élémentaire. La première étape

consiste à remarquer que X n'est pas inversible en remarquant que

2/j,x(0) = tr(iJ,x(X)) = 0. Ainsi, en considérant une base construite en

complétant une base du noyau de X, la matrice X est semblable à une

matrice de la forme

(!;)■

La condition trX = 0 entraîne alors /3 = 0. La matrice X est donc

semblable à une matrice triangulaire supérieure donc nilpotente.

On montre de même que Y est nilpotente.

2. Supposons ker X = ker Y et considérons une base de A42,1 (C) construite

à partir d'un vecteur directeur de ker X. Alors, il existe une matrice P G

GL2(C) telle que

.v=p(°;)p-, y=p(2i)p-

La condition sur les traces nulles entraîne f3 = ô = 0. Ainsi, X et Y

sont proportionnelles.

Enfin, notons que si X et Y sont proportionnelles, XY — YX = O2 ce

qui entraîne H = O2, cas explicitement exclu par l'énoncé.

3. Nous avons montré à la question précédente que les droites ker X et ker Y

sont supplémentaires dans A^2,i(C). Considérons une base associée à

cette décomposition telle qu'il existe une matrice P G GL2(C) vérifiant

Il reste alors à vérifier les conditions de l'énoncé.

> Avec H = XY — YX, on trouve

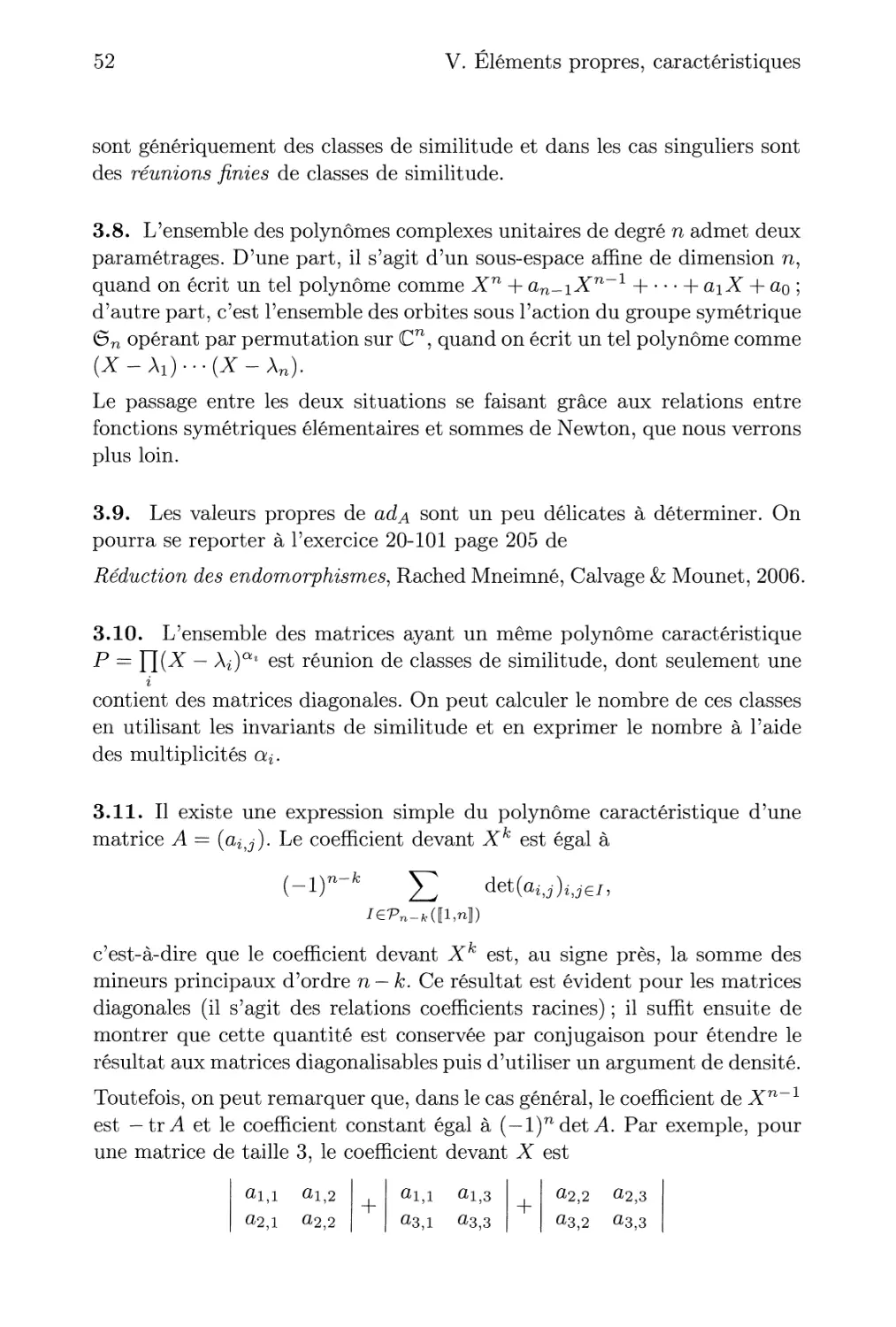

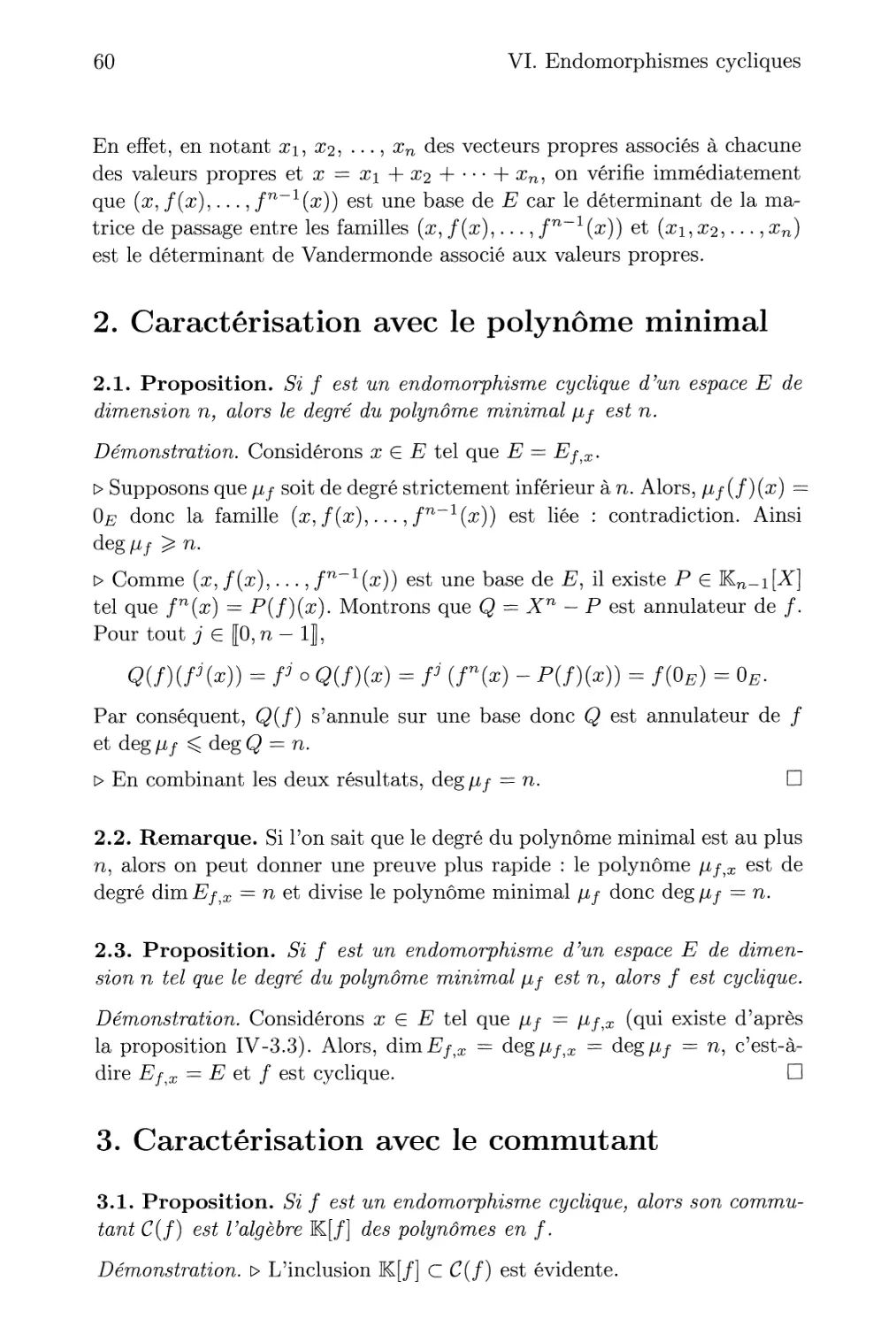

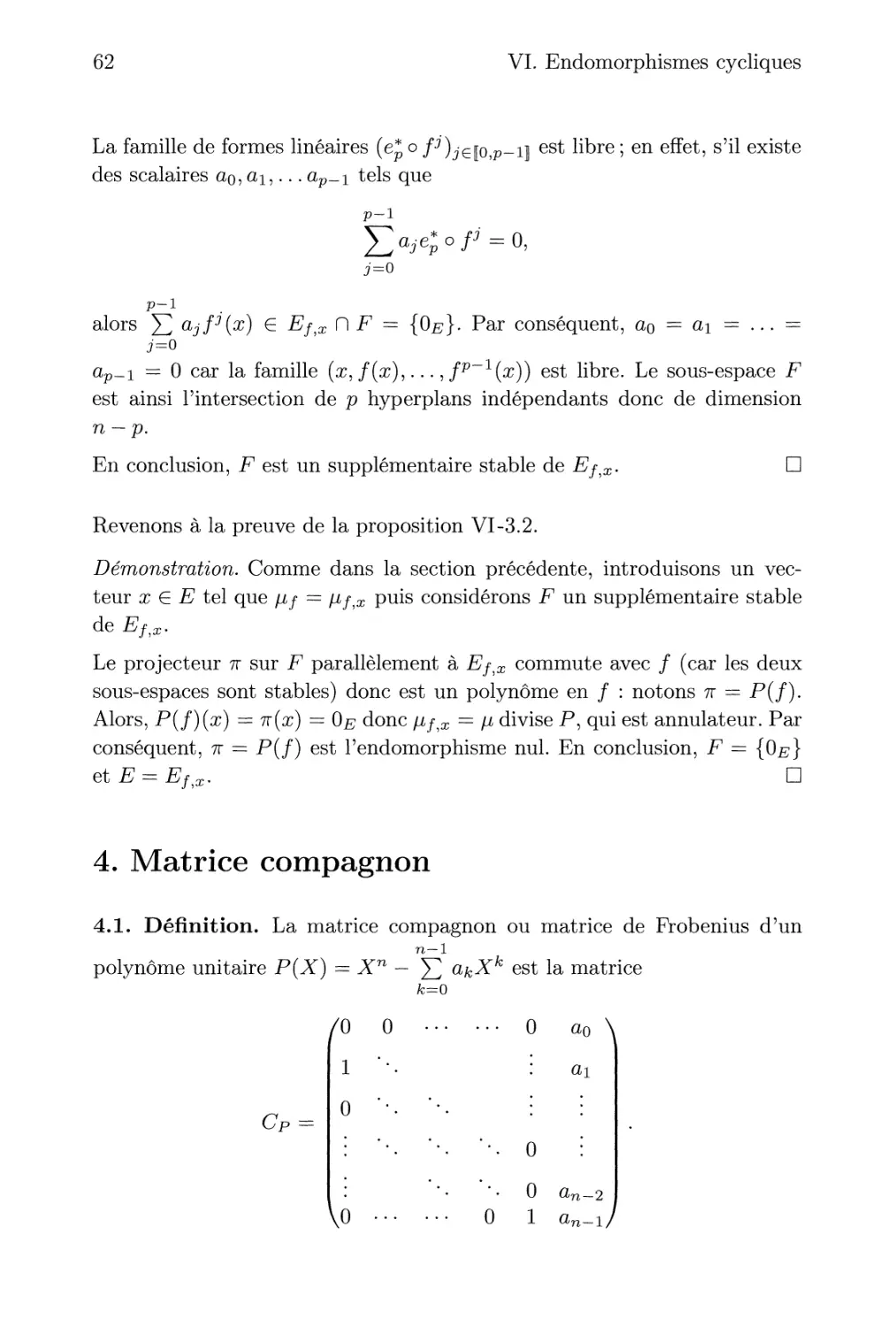

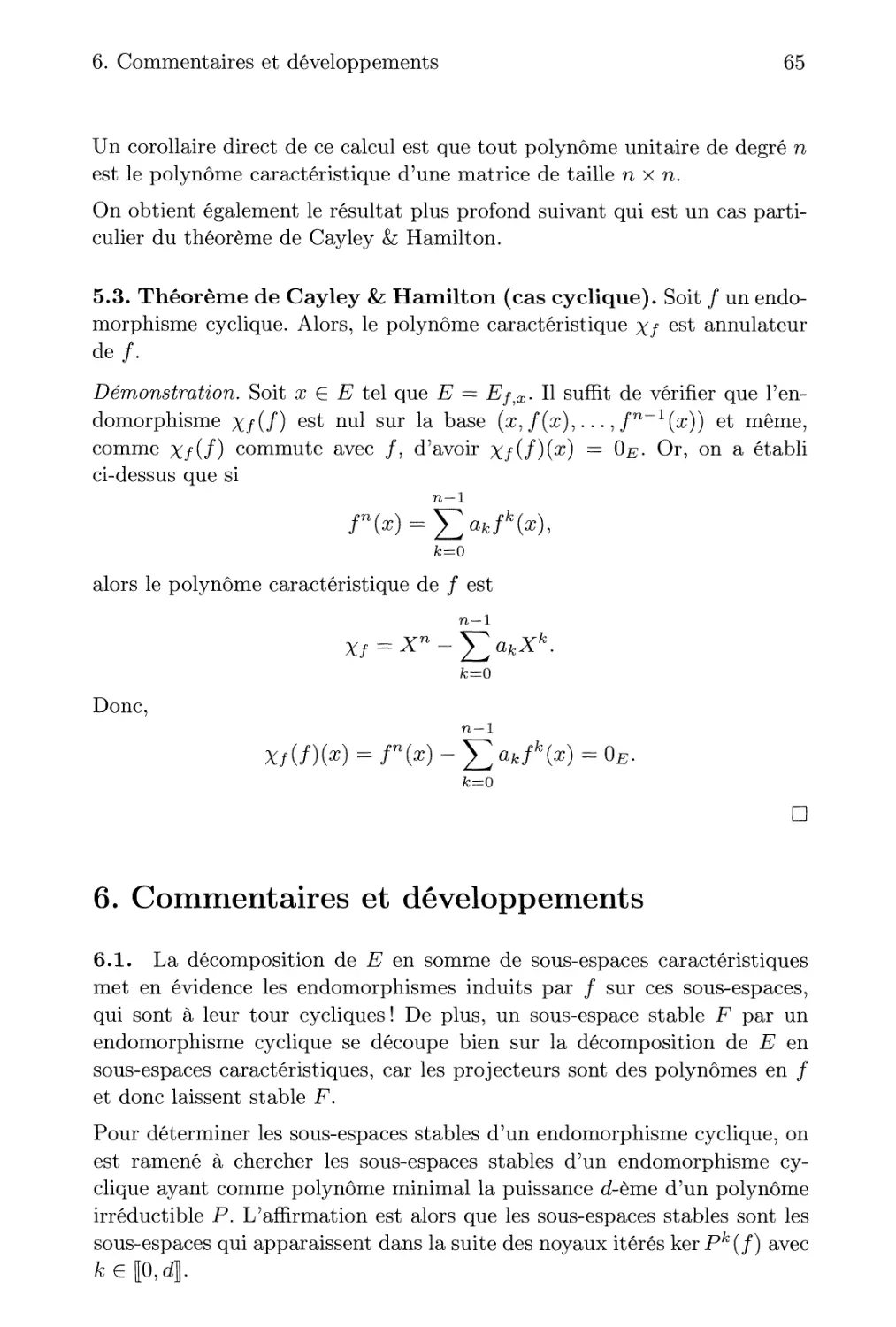

> Avec 2X = HX-XH, on trouve a = 1. La condition 2Y = YH-HY