Текст

М. М. БОНГАРД

ПРОБЛЕМА УЗНАВАНИЯ

ИЗДАТЕЛЬСТВО «НАУКА»

ГЛАВНАЯ РЕДАКЦИЯ

ФИЗИКО-МАТЕМАТИЧЕСКОЙ ЛИТЕРАТУРЫ

МОСКВА 1 967

6П2.15 Михаил Моисеевич Бонгард

Б 81 ПРОБЛЕМА УЗНАВАНИЯ

УДК 519.95 Mj 1967 Tf 320 стр. с илл.

Редактор Р. С. Гутер

Художник Я. И. Максимов

Худ. редактор И. И. Румянцев

Техн. редактор И. Ш. Аксельрод

Корректор С. Я. Емельянова

Сдано в набор 2/ХИ 1966 г. Подписано к печати 26/IV 1967 г.

Бумага 84 х 108!/<й- Физ. печ. л. 10. Условн. печ. л. 16,8.

Уч.-изд. л. 16,77. Тираж 20 000 экз. Т-06903. Цена книги 78 коп.

Заказ № 462.

Издательство «Наука»

Главная редакция физико-математической литературы.

Москва, В-71, Ленинский проспект, 15.

Ленинградская типография № 2 имени Евгении Соколовой

Главполиграфпрома Комитета по печати

при Совете Министров СССР. Измайловский проспект, 29.

3-3-14

177-Ь7

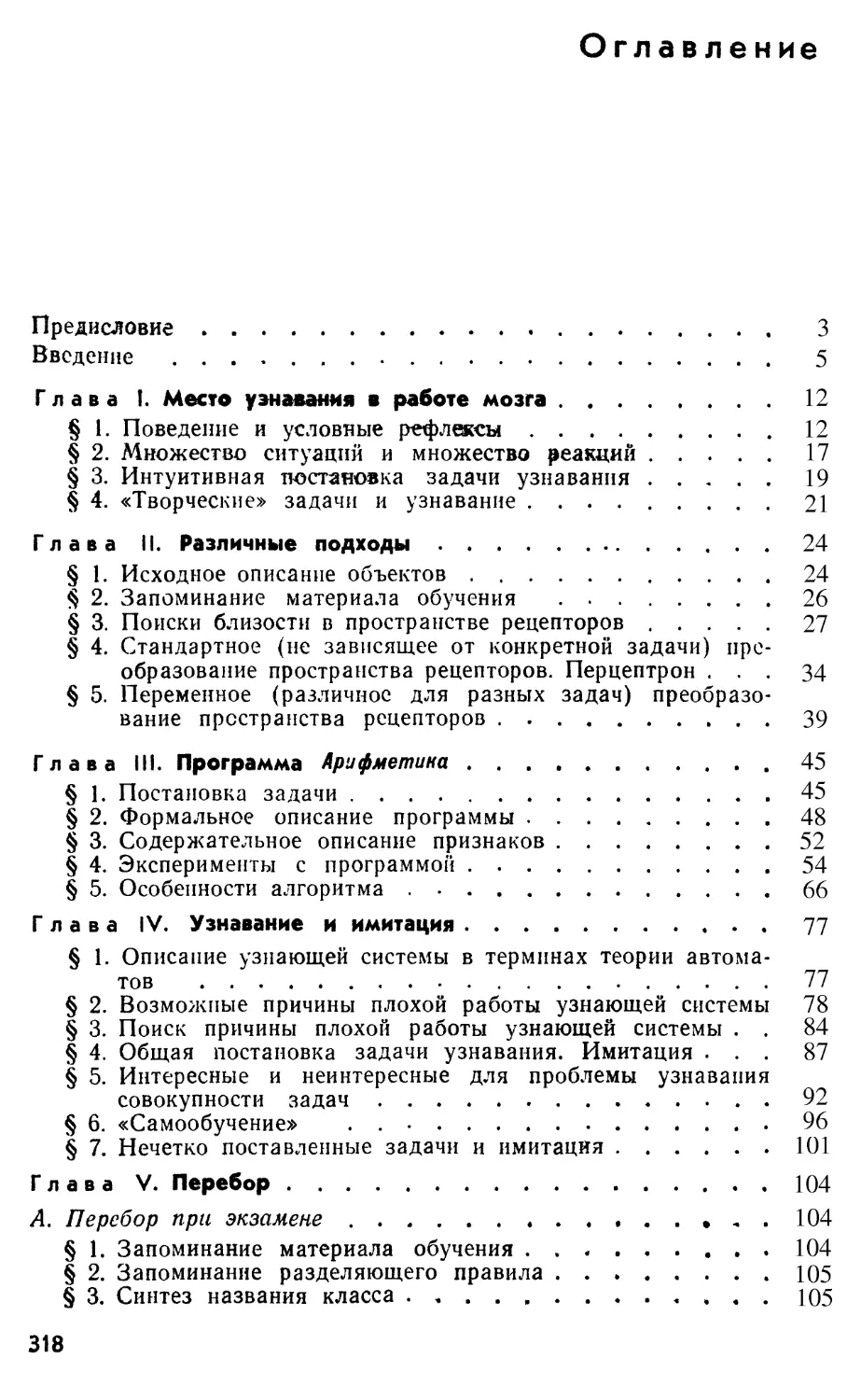

Предисловие

В настоящее время многие исследователи занимаются созданием

устройств, моделирующих способность человека решать широкий

круг разнообразных задач. Возникающая при этом принципиальная

трудность заключается в том, что эти задачи часто ставятся не в

формализованном виде, а путем показа нескольких примеров,

указания аналогичных случаев, ссылок на некоторое сходство и т. п.

Разные авторы называют подобные устройства «узнающими»,

«ведущими эвристический поиск» и т. п. Данная книга не является

ни учебником, ни, тем более, обзором многочисленных' работ,

ведущихся в этих направлениях. Она содержит главным образом

соображения, возникшие в результате совместной работы группы, в

которую кроме автора входили М. Н. Вайнцвайг, В. В. Максимов,

и М. С. Смирнов.

Выбор неформализованных задач в качестве объекта

исследований создает трудности не только при построении устройств,

способных решать эти задачи. Трудность возникает и при попытке

теоретически оценить возможности того или другого устройства.

Создается необычная для математики (разделом которой,

по-видимому, целесообразно считать «проблему узнавания») ситуация,когда

трудно доказать какие-либо теоремы, а приходится прибегать к

эксперименту. Такое положение является, вероятно, временным,

однако предпринятые до сих пор попытки формализовать постановку

вопроса в проблеме узнавания приводили или к «выплескиванию

ребенка» (подмене задачи узнавания другой более примитивной

задачей), или к определениям, которые пока мало плодотворны, так

как мы еще не умеем оговорить некоторые существенные

ограничения.

Может возникнуть вопрос: а стоило ли писать книгу о столь

неопределенном и неустоявшемся предмете? Автору кажется, что

стоило. Дело в том, что сейчас, по-видимому, уже вырисовываются

достаточно общие подходы к проблеме. С другой стороны, много

людей, не дожидаясь появления строгой математической теории,

начинает заниматься различными аспектами проблемы узнавания.

Инженеры и психологи, физики и врачи, математики и физиологи

сталкиваются с необходимостью понять или промоделировать такие

функции мозга, как способность «находить сходство», «обобщать»,

«создавать абстрактные понятия», «действовать на основе интуиции»

и т. п. Знакомство с уже проделанной работой может облегчить

труд этих людей, сделать их поиск более целеустремленным,

предостеречь от движения в мало перспективных направлениях.

Многие понятия вводятся в книге на интуитивном уровне.

В принципе это может привести к недоразумениям. Для уменьшения

3

вероятности таких недоразумений нужно, чтобы запасы

фактических сведений (на которых в значительной мере базируется

интуиция) читателя и автора были близки между собой. Поэтому в

книге приводится описание нескольких конкретных программ, в

процессе работы над которыми формировались взгляды автора. Особое

внимание уделяется неудачным блокам, так как именно выяснение

причин неудач обычно помогает двигаться вперед.

Желание автора дать чига1елю конкретный материал для

размышлений привело к тому, что описание программы Арифметика

(на примере которой вводятся понятия признак, преобразование

пространства рецепторов и т. п.) предшествует более абстрактному

вопросу об имитации автоматом другого автомата, хотя, согласно

принятой в книге логической схеме, именно нмикация является

«первичным» понятием.

Таким образом, порядок глав не всегда отражает внутреннюю

структуру материала (да и вряд ли он сегодня может быть

хорошо линейно упорядочен). Однако в тексте имеется очень много

явных и неявных ссылок на ранее изложенные факты и

соображения, поэтому есть смысл читать книгу подряд. Исключение,

пожалуй, составляет глава VII о полезной информации, которая

довольно естественно следует за главами V и VI, но вовсе не обязательно

должна предшествовать главе VIII и потому практически без

ущерба для понимания дальнейшего может быть пропущена при чтении.

Можно также рекомендовать читателю уже при чтении главы II

ознакохмиться с приложением 3 («задачник»). Это поможет ему

почувствовать природу трудностей проблемы узнавания.

Одной из главных задач автора было обратить внимание

читателя на взаимосвязь различных разделов проблемы узнавания

между собой и на аналогии между проблемой узнавания и смежными

областями. Разнообразие таких «точек соприкосновения» привело

к тому, что разные аспекты одного и того же вопроса иногда

обсуждаются в нескольких главах.

В создании описанных в книге программ, в экспериментах

с ними и в психофизиологических опытах принимали участие Л.

Дунаевский, Г. М. Зенкин и А. П. Петров, которым автор приносит

искреннюю благодарность.

Автор глубоко признателен Э. М. Бравермаиу, Р. С. Гутеру и

Н. Д. Нюбергу, подробно ознакомившимся с рукописью и

высказавшим ряд полезных замечаний.

Автору выпало счастье неоднократно обсуждать проблему

узнавания с оригинальным, необыкновенно тонко чувствующим новые

направления ученым М. Л. Цетлиным. Буквально за несколько дней

до своей трагической скоропостижной кончины Михаил Львович

прочел рукопись книги и дал много ценных советов. Светлая память

об этом замечательном человеке в сердцах многих будет неразрывно

связана с любыми вопросами, возникающими при исследовании

организации сложного поведения, а значит, и с проблемой

узнавания.

М, Бонсард

25.6 1966 г.

ВВЕДЕНИЕ

В течение последних десяти лет на страницах

научно-фантастических рассказов фигурирует все больше

и больше «роботов», «киберов» и прочих устройств,

снабженных «электронным мозгом». Эти автоматы

ведут непринужденную беседу с человеком на

всевозможные темы и обладают целесообразным поведением.

Поведение их настолько сложно, условия, к которым

они могут приспособиться, настолько разнообразны, что

иначе чем разумными такие машины не назовешь. В

зависимости от сюжета роботы бывают добрыми или

злыми, коварными или готовыми на самопожертвование,

комически ограниченными или всезнающими

мудрецами, но во всех случаях авторское отношение писателя

к такому роботу напоминает скорее отношение к

человеку, чем к машине.

Ничего сколько-нибудь напоминающего подобных

роботов мы сегодня в реальной жизни не видим. Для

сравнения вспомним, что, например, прообразы всех

конструкций, описанных у Жюля Верна, имелись в

технике того времени. Возникает вопрос: что же в

рассказах «из жизни роботов» — «научно», а что — «чистая

фантастика»? Не придумали ли писатели в погоне за

необычными ситуациями нечто, чего быть

принципиально не может? Ведь изобретение вечного двигателя тоже

могло бы послужить неплохой темой фантастического

рассказа, если бы только читатели не были поголовно

«испорчены» знанием закона сохранения энергии.

Ответ на этот вопрос таков: создание роботов, сколь

угодно близко имитирующих поведение человека, не

противоречит никаким известным в настоящее время

законам природы. Более того, писатели-фантасты не сами

Додумались до принципиальной возможности такой

имитации. Эту идею они позаимствовали у ученых*).

*) См., например, А. Тьюринг, Может ли машина мыслить?

Физматгиз, М., 1960.

5

Почему же ученые, уже несколько десятилетий

понимающие принципиальную возможность создания

думающих машин, до сих пор их не сделали?

После появления универсальных вычислительных

машин с программным управлением у

ученых-энтузиастов возникло ощущение некоего всемогущества

программиста. Захочет — заставит машину решать систему

уравнений, захочет — она будет играть в шахматы,

захочет— займется переводами с английского языка на

русский. А если написать соответствующую программу,

то универсальная машина воспроизведет любой вид

человеческой деятельности. Конечно, чем сложнее

деятельность, тем длиннее получится программа и тем

больше врехмени потребуется машине для работы. По

существу, отсюда следовало: дайте нам большую

память и большую скорость работы — и мы сделаем

«думающую» машину.

Можно сказать, что кибернетика выдала крупный

вексель. Однако он до сих пор практически совсем не

оплачен. И в основном не из-за малой скорости и

недостаточного объема памяти современных машин.

Причина в другом — не хватает идей. Идей о способах

построения программ для имитации сложного поведения

человека в разнообразных обстоятельствах. В чем же

причина трудности?

Очень легко написать программу, если машина

должна всегда (при всех обстоятельствах, с которыми

она может столкнуться) совершать одну и ту же

последовательность операций. Например, чтобы вычислить

значение выражения a2 + b—-ab + b2, она должна (при

любых а и Ь) возвести число а в квадрат, к результату

прибавить Ъ и т. д.

Иначе обстоит дело в случае, когда при разных

обстоятельствах требуется разный порядок действий.

Однако сложность возрастает не намного, если можно

заранее четко сформулировать, чем должен определяться

выбор следующей операции в тех или иных случаях.

Например, если требуется при любых а вычислять йп

(п — целое положительное число), то машина должна

каждый раз перед умножением ранее полученного

результата на а сравнивать число уже произведенных

умножений с /г. В зависимости от результата этого

сравнения нужно или произвести очередное умножение (если

6

их было сделано еще недостаточно), или напечатать

ответ и остановиться. Ясно, что написать программу

такой работы несложно.

Серьезные трудности начинаются тогда, когда

нельзя заранее решить, чем должен определяться выбор

порядка операций в машине. Когда принцип этого выбора

зависит от многих обстоятельств и характер

зависимости тоже не может быть указан заранее, а должен

определиться в результате рассмотрения некоторых других

обстоятельств, однако метод рассмотрения нельзя

задать один и тот же на все случаи машинной жизни. Он

должен быть выбран машиной в соответствии с

конкретными особенностями задачи, а принцип выбора... (см.

начало предыдущей фразы и повтори этот цикл 20, а то

и 100 раз).

Именно такая степень сложности программы

понадобится, если мы захотим имитировать способность

человека решать множество задач и приспосабливаться

к очень разнообразным условиям. Заметим при этом,

что поведение машины, управляемой подобной

многоступенчатой программой, будет выглядеть вовсе «не

машинным». Ее действия будут настолько сложно зависеть

от такого великого множества обстоятельств (в том

числе и далеко отстоящих во времени), что внешне будет

полная иллюзия свободы воли в принятии решений (так

же как есть иллюзия «свободы воли» у человека).

«Ну и пусть нужна сложная программа, — может

подумать тут читатель. — Почему бы не начать писать

команду за командой программу такой деятельности?

Даже если тратить по часу на одну команду, то,

глядишь, за 5 лет кое-что интересное и получится!»

К сожалению, такой метод «штурма проблемы в

лоб» вряд ли может удаться. Причин этого несколько;

мы остановимся на одной из них, главной с нашей

точки зрения. Программист, который попытался бы шаг за

шагом писать программу для думающей машины, очень

скоро заметил бы, что он сам не в состоянии просле*

дить, какие обстоятельства, на что и по каким законам

должны влиять. А при рассматриваемом способе

создания программы без таких знаний программист работать

не может. Нельзя требовать от человека (а программист

тоже человек) очень детального знания устройства

очень сложной системы.

7

Проиллюстрируем это соображение примером.

Допустим, соотношение скоростей развития техники и

различных наук на Марсе было совсем не таким, как на

Земле. Марсиане уже постигли законы взаимодействия

элементарных частиц, но еще не знают ни химии, ни

даже механики больших тел. Единственный их способ

передвижения на большие расстояния — это верхом

(колесо еще неизвестно). Пусть некий великий

марсианский ученый догадался, что способность передвигаться

за счет внутренних запасов энергии не есть

исключительное свойство живых организмов*). На основе этого

открытия решено построить автомобиль. (Пока что это

слово для марсиан отражает чисто функциональное

свойство будущей конструкции — способность к

«самодвижению».)

Задача, поставленная перед конструкторским бюро,

звучала на языке марсиан так: требуется найти такое

расположение некоторого числа атомов в пространстве,

чтобы их совокупность могла перевозить человека по

хорошей дороге со скоростью не меньшей, чем лошадь.

Конструкторы взялись за работу. Их вдохновляло

понимание того, что такое расположение атомов в

пространстве заведомо существует (лошадь-то тоже состоит

из атомов!). Однако, как расположены атомы в лошади,

они выяснить, при своем уровне экспериментальной

техники, не могли. Поэтому было решено шаг за шагом

(атом за атомом) усложнять конструкцию, пока она не

начнет сама двигаться...

Нам понятно, что затея марсиан обречена на

неудачу. Нельзя понять работу столь сложного устройства,

как автомобиль (или ткацкий станок, или

радиоприемник и т. п.), думая о нем только в терминах

элементарных частиц и их взаимодействия.

Для понимания (а тем более для придумывания

вновь) совершенно необходимо уметь коротко

описывать большие группы частиц. Затем нужны короткие

описания совокупностей таких групп и т. д. В примере

с автомобилем это значит, что сначала должно

выработаться понятие материала. Это дает возможность

коротко описывать (сохраняя всю существенную для дела

*) Фантастические романы марсиан, издаваемые рукописно на

березовой коре, сразу переполнились описаниями «самоходов».

8

информацию) очень большие группы атомов. Например,

вместо указания местоположения и связей всех 3-Ю27

атомов, находящихся внутри бензобака, вполне

достаточно сказать, что там имеется 40 литров бензина с

такой-то теплотворной способностью, таким-то удельным

весом, таким-то октановым числом и т. д.

Благодаря коротким описаниям свойств бензина,

латуни, стали и т. д. может работать, например,

конструктор двигателя, который, вероятнее всего, ничего не

смыслит в химии, не говоря уж о квантовой механике.

И, наконец, конструктор «автомобиля в целом»

видит в двигателе агрегат с такими-то габаритами, весом,

мощностью и т. п. Ему нет нужды, продумывая

вопрос— впереди или сзади лучше расположить

двигатель,— каждый раз вспоминать, в какой

последовательности открываются клапаны.

Именно умение думать «не атомами, а крупными

блоками» и дало возможность людям создать

достаточно сложные устройства. И именно отсутствие такой

возможности лишает марсиан надежды на успех. Пока они

не создадут предпосылок для «крупноблочного

мышления» (механики, химии, технологии материалов и т. п.),

им придется довольствоваться сознанием того, что

изготовить автомобиль в принципе возможно, ездить же

на автомобилях будут только герои фантастических

романов.

В отношении создания «думающих машин»

человечество находится примерно в том же положении, что

описанные марсиане в отношении «самодвижущихся

машин». Мы понимаем, что из отдельных команд

универсальной вычислительной машины можно построить

программу мышления, так же как марсиане понимают,

что из атомов можно построить автомобиль. И так же

как марсианам не хватает знания того, из каких

агрегатов (гораздо более крупных, чем отдельные атомы)

должен состоять автомобиль, нам не хватает

понимания того, из каких крупных блоков можно

составить «мышление», из каких более мелких (но все еще

состоящих из очень многих команд) блоков должны

состоять крупные и т. д.

Поэтому, если мы хотим перейти от фантастических

рассказов к делу, то нужно искать блоки намного более

простые, чем мышление в целом, но намного более

9

сложные, чем отдельные команды. При этом

необходимо, чтобы свойства блока (существенные для

построения мышления) можно было описать гораздо короче,

чем перечислением всех команд, из которых он состоит.

Тогда появится возможность построить из этих блоков

более сложные блоки и т. д.

По-видимому, узнавание является одним из таких,

важных для построения мышления, блоков. В данной

книге мы будем рассматривать его именно в этом

аспекте. Такой подход предопределяет, что будет казаться

нам в проблеме узнавания интересным и что — не

интересным. Например, мы почти не будем рассматривать

необучаемые узнающие системы, так как они не

моделируют способности мозга гибко приспосабливаться к

разным обстоятельствам. И вообще, когда в книге будет

идти речь о том, что что-то интересно или не интересно

для проблемы узнавания, всегда будет

подразумеваться, что проблема узнавания — это часть проблемы

мышления. Естественно, деление вопросов на интересные и

не интересные будет изменяться со временем.

Интересное и нетривиальное сегодня может стать скучным и

тривиальным завтра. Деление, проводимое в книге,

отражает сегодняшнюю точку зрения автора.

Когда химик ищет способ синтеза нового вещества,

он никогда не начинает с постройки специального

завода для производства этого вещества. Он

экспериментирует с небольшими количествами реактивов,

пользуясь одними и теми же пробирками и колбами для

самых разнообразных опытов. И лишь потом, когда метод

разработан, строится специализированный завод,

выпускающий большие количества, скажем капрона, но уже

непригодный для экспериментов в другой области.

Работы по созданию интересных узнающих систем

находятся сейчас в стадии начальных опытов. Поэтому

нет смысла строить для этих опытов

специализированные машины. Гораздо выгоднее писать программы для

универсальных машин. Так в большинстве случаев и

поступают. Сам способ работы подчеркивает то

обстоятельство, что главная трудность построения узнающей

системы — не поиск элементов, из которых нужно ее

делать, а отыскание логики совместной работы большого

количества элементов. Программист может не

интересоваться, собрана универсальная машина на лампах,

Ю

транзисторах или криогенных «нейристорах». Ему

достаточно знать, какую команду нужно отдать машине,

чтобы она совершила то или иное действие. Поэтому все

внимание программиста сосредоточено на тех

преобразованиях, которым нужно подвергнуть исходный

материал, чтобы получить требуемый результат. Конечно,

каждая программа учитывает специфику той машины,

на которой ведется работа, однако путем несложной

переделки программу можно приспособить к любой

универсальной машине. Особенности той или другой

узнающей системы в основном определяются свойствами

программы, а не машины. Поэтому мы часто будем

отождествлять программу (или алгоритм) с узнающей

системой. В книге будут встречаться слова: программа

учится, программе показали, программа ответила и т. п.

Последнее выражение, например, означает, что машина,

управляемая программой, напечатала ответ.

Еще несколько слов о словах. Мы будем называть

узнаванием совокупность всех процессов в системе,

включая и процесс обучения. Чтобы не возникло

путаницы, процесс применения сведений, запасенных во

время обучения, будет называться экзамен. Таким образом,

узнавание состоит из обучения и экзамена.

В литературе часто можно встретить выражения:

узнавание образов или распознавание образов. При

этом разные авторы вкладывают в слово «образ»

разный смысл. Некоторые подразумевают, что образ — это

единичный объект. Другие понимают под образом класс

объектов. Третьи считают, что образ — это класс, но не

любой, а лишь удовлетворяющий некоторым, раз

навсегда заданным (и довольно жестким) условиям. Согласно

этой системе терминологии возможны классы,

являющиеся образами, и классы, не являющиеся образами.

При таком разнобое, в каком бы смысле мы ни стали

применять слово образ, кто-нибудь да поймет его

неверно. Поэтому в книге оно нигде не встречается. Мы

будем говорить об объектах и о классах объектов.

В тех же случаях, когда по смыслу дела нужно будет

наложить ограничения на разрешенные способы

классификации, эти ограничения (они разные в различных

случаях) будут отдельно оговариваться.

Глава I

МЕСТО УЗНАВАНИЯ В РАБОТЕ МОЗГА

§ 1. Поведение и условные рефлексы

Во введении говорилось, что для построения

думающей машины необходимо уметь разбить операции,

выполняемые мозгом, на достаточно крупные блоки. При

этом нужно, чтобы свойства каждого блока могли быть

коротко описаны. Описание должно включать в себя

указание на способы, которыми блоки соединяются

между собой.

Не целесообразно ли обратиться за помощью к

сведениям о работе мозга? Многие из физиологов ведь

специально занимаются выяснением того, как организуется

сложное поведение животных. Почему бы не применить

открытые' ими принципы при построении искусственных

систем?

В течение некоторого времени многим казалось, что

принцип работы высших отделов мозга, по крайней

мере в общих чертах, разгадан. После исследований

И. П. Павлова в области условных рефлексов создалось

впечатление, что с помощью комбинации большого

числа условных рефлексов различных порядков можно

организовать сколь угодно сложное поведение. Еще

пятнадцать лет тому назад многие физиологи, подражая

Архимеду, рискнули бы сказать: «Дайте нам

достаточное количество блоков, способных вырабатывать

условный рефлекс, и мы построим из них систему, которая

путем обучения будет приспосабливаться к внешней

обстановке. Эта система будет целесообразно вести себя

в условиях, изменяющихся в очень широких пределах».

Может быть, «условные рефлексы» и есть те блоки, из

которых имеет смысл собирать думающую машину?

К сожалению, физиологи не дали четкого определения,

12

что же такое «условный рефлекс», а без определения

невозможно ответить на поставленный вопрос. Поэтому

попробуем сами дать определение условного рефлекса,

постаравшись, конечно, чтобы с ним могли согласиться

физиологи — специалисты в этой области.

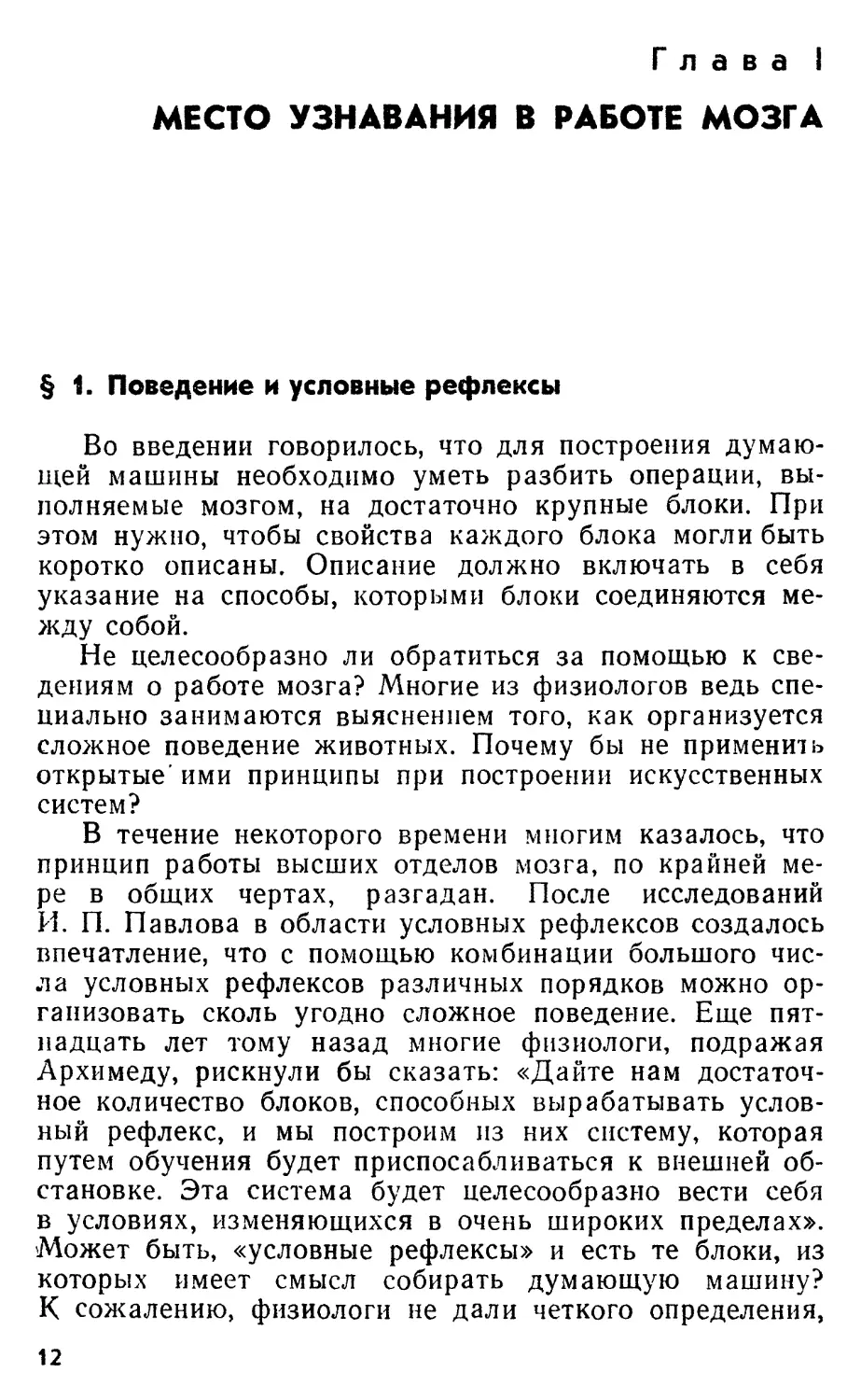

Пусть штриховой прямоугольник на рис. 1

изображает «условный рефлекс». Этот блок имеет два входа

(А и В) и один выход (С). Вход Л является

«безусловным раздражителем». Сигнал с него всегда, независимо

A i ГТ ч С

Н Г W Г 1 *»

Рис. 1. Схема условного рефлекса.

от обучения, передается на выход С. Вход В является

условным раздражителем. Вначале контакт К

находится в разомкнутом состоянии и сигнал, приходящий от В,

не проходит к С. Однако, если сигналы Л и В несколько

раз приходят одновременно, то блок совпадений (Б. С)

замыкает контакт К. Теперь сигнал В начинает

вызывать реакцию С и без сигнала А. Так будет до тех пор,

пока несколько раз подряд не случится, что сигнал В

придет в отсутствие сигнала А («без подкрепления»).

Тогда блок совпадений разомкнет контакт К

(«условный рефлекс угаснет»). Вентили, изображенные в

каналах А и В, предотвращают попадание сигнала из

капала Л в В и наоборот, и защищают блок Б. С. от

«самоподкреплений» после того, как контакт К замкнется. Мы

весьма упрощенно описали правило работы блока

совпадений. На самом деле весьма существенны временные

соотношения между приходами сигналов Л и В,

перерывами в приходе сигналов, перерывами в «подкреплении»

сигнала В и т. п. Именно исследование свойств блока

совпадений и составляло содержание многих работ по

изучению условных рефлексов. (Например, часть

классических опытов И. П. Павлова велась в условиях,

когда сигналом Л являлся сигнал о вкусе пищи, В —

был сигнал о загоревшейся лампочке, а С — сигнал,

стимулирующий выделение слюны.)

13

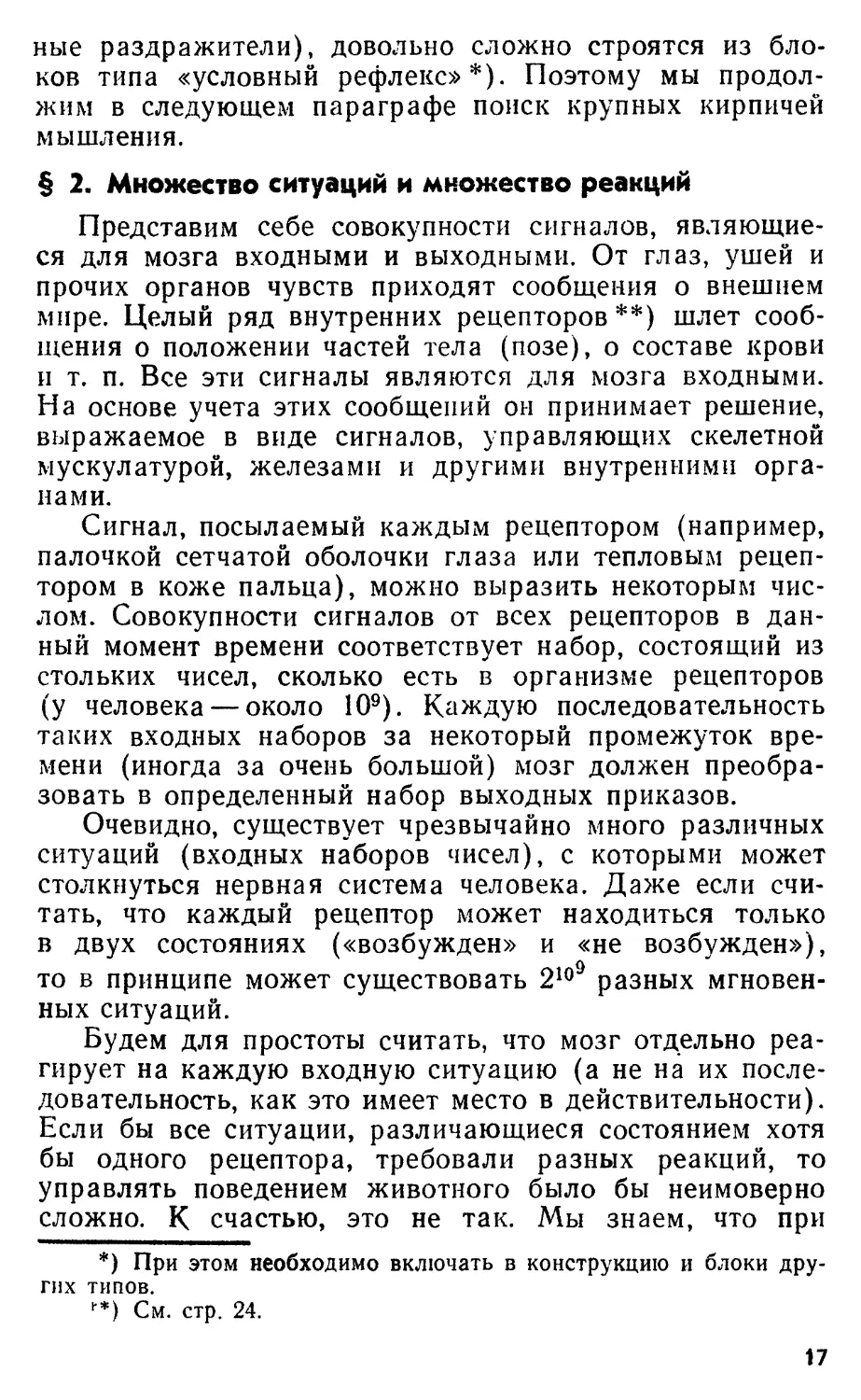

Легко построить из таких «условных рефлексов»

«рефлекс второго порядка»*). Для этого достаточно

соединить выход одного блока «условный рефлекс» с

одним из входов второго блока (рис. 2).

Очевидно, соединяя между собой большое число

«условных рефлексов», можно получить рефлексы

Лища

СЗет

Збук

У

-И—' !

"I Слюна

о)

Лаща

Сбет

ча-

Збуп

л

-Of-

"1 Слюна

*J \

*)

Рис. 2. Схемы рефлексов второго порядка. Схема а)

позволяет вырабатывать рефлекс второго порядка, сочетая звук

со светом как до, так и после выработки условного рефлекса

на свет. Схема б) работает только в том случае, если звук

сочетается со светом после того, как выработан рефлекс на

свет. (Зато можно выработать рефлекс на звук, сочетая его

непосредственно с пищей).

третьего, четвертого и т. д. порядков. Вернемся к

вопросу: любую ли форму поведения можно получить,

комбинируя между собой блоки типа «условный рефлекс»?

Теперь, когда под условным рефлексом мы понимаем

(пусть хотя бы временно) вполне определенную вещь,

этот вопрос решается отрицательно.

Начнем с того, что система, составленная из

произвольного числа условных рефлексов, может совершать

лишь такие действия, для которых с самого начала

*) Физиологическим примером может служить ситуация, когда

пища сочетается со светом, свет (без пищи) сочетается со звуком,

после чего звук (в отсутствие пищи и света) начинает вызывать

выделение слюны.

14

имелись безусловные раздражители. В самом деле,

«обучение» (сочетание разных раздражителей) такой

системы может привести лишь к замене (в смысле

стимулирования действия) безусловного раздражителя

условными. Если для какого-то действия нет

безусловного (врожденного) раздражителя, то и заменять

нечего. Например, получить после обучения выделение

слюны в ответ на свет или звук в схемах на рис. 2, а и

2,6 возможно лишь потому, что есть безусловный

раздражитель (пища) для слюноотделения.

Животные же обучаются множеству действий, для

которых не существует безусловных стимулов. Никакое

сочетание звуков, вкусовых воздействий или световых

эффектов не заставит необученную собаку пройти 5

метров на передних лапах, сохраняя равновесие. В ходе

дрессировки происходит не замена одного стимула

другим, а выработка новой, ранее не существовавшей

реакции.

Заметим, что невозможность выработать новые

действия с помощью совокупности условных рефлексов

является следствием общей структуры этого блока, а не

какого-то конкретного алгоритма работы блока

совпадений. Наш вывод остается в силе, например, при

любых законах «выработки рефлекса» или «угасания

рефлекса» и т. п.

Ограничимся теперь на время лишь такими

реакциями, для которых существуют безусловные

раздражители. Можно ли хоть в этом случае воспроизвести с

помощью условных рефлексов все доступные животным

формы поведения?

Если собаке давать пищу после

одновременного воздействия света и звука и не давать после того,

как включали только лампочку или только звонок,

то она очень быстро начнет выделять слюну в ответ на

одновременное включение лампочки и звонка и не

реагировать на эти раздражители порознь. И такую

нехитрую реакцию на «комплексный раздражитель»

невозможно свести ни к какому количеству условных

рефлексов.

«Ладно, — скажет здесь читатель, — согласен, что

условный рефлекс не является универсальным блоком,

из которого можно построить всю деятельность мозга.

Но, может быть, если к «условному замыкателю»,

15

изображенному на рис. 1, добавить еще несколько

типов блоков, то удастся получить универсальный набор?

Другими словами, не является ли условный рефлекс

одним из основных блоков, на которые

распадается мышление?»

Это замечание частично справедливо. Действительно,

очень небольшое число типов блоков может быть

достаточным для построения сколь угодно сложного

поведения. Например, если к «условному рефлексу» добавить

еще безусловное торможение (один сигнал размыкает

цепь другого сигнала) и «спонтанное возбуждение»

(внутренний источник сигнала), то получится

универсальная система.

Отсюда, однако, вовсе не следует, что

целесообразно строить думающую машину из условных

рефлексов, безусловных торможений и спонтанных

возбуждений. Дело в том, что существует много разных

универсальных наборов блоков. Например, из блоков,

выполняющих логическую операцию «И», «логическое

отрицание», и линий, задерживающих сигнал, также

можно собрать машину, реализующую любое

поведение. И, наконец, просто система команд любой

универсальной машины дает возможность построить любую

программу. Вспомним, что, уже обладая

универсальной, системой команд, мы поставили

вопрос о тех крупных (по сравнению с отдельной

командой) блоках, из которых можно строить сложное

поведение. Именно в поисках таких блоков мы

заинтересовались условными рефлексами. Поэтому нам важна

не столько принципиальная возможность построить что

угодно (она гарантируется уже системой команд

машины), сколько удобство построения функций,

являющихся более крупными блоками, чем условные

рефлексы.

С этой точки зрения условные рефлексы не

являются особо удачными «кирпичами» мышления. Во-первых,

они выполняют только весьма примитивную функцию —

учитывают совпадение во времени некоторых событий.

Можно сказать, что они еще недалеко ушли от

элементарных команд (являются слишком мелкими блоками).

Во-вторых, даже функции, весьма близкие к простому

условному рефлексу (например, рефлексы на комплекс-

16

ные раздражители), довольно сложно строятся из

блоков типа «условный рефлекс»*). Поэтому мы

продолжим в следующем параграфе поиск крупных кирпичей

мышления.

§ 2. Множество ситуаций и множество реакций

Представим себе совокупности сигналов,

являющиеся для мозга входными и выходными. От глаз, ушей и

прочих органов чувств приходят сообщения о внешнем

мире. Целый ряд внутренних рецепторов**) шлет

сообщения о положении частей тела (позе), о составе крови

и т. п. Все эти сигналы являются для мозга входными.

На основе учета этих сообщений он принимает решение,

выражаемое в виде сигналов, управляющих скелетной

мускулатурой, железами и другими внутренними

органами.

Сигнал, посылаемый каждым рецептором (например,

палочкой сетчатой оболочки глаза или тепловым

рецептором в коже пальца), можно выразить некоторым

числом. Совокупности сигналов от всех рецепторов в

данный момент времени соответствует набор, состоящий из

стольких чисел, сколько есть в организме рецепторов

(у человека — около 109). Каждую последовательность

таких входных наборов за некоторый промежуток

времени (иногда за очень большой) мозг должен

преобразовать в определенный набор выходных приказов.

Очевидно, существует чрезвычайно много различных

ситуаций (входных наборов чисел), с которыми может

столкнуться нервная система человека. Даже если

считать, что каждый рецептор может находиться только

в двух состояниях («возбужден» и «не возбужден»),

то в принципе может существовать 21°9 разных

мгновенных ситуаций.

Будем для простоты считать, что мозг отдельно

реагирует на каждую входную ситуацию (а не на их

последовательность, как это имеет место в действительности).

Если бы все ситуации, различающиеся состоянием хотя

бы одного рецептора, требовали разных реакций, то

управлять поведением животного было бы неимоверно

сложно. К счастью, это не так. Мы знаем, что при

*) При этом необходимо включать в конструкцию и блоки

других типов.

*•*) См. стр. 24.

17

решении каждой конкретной задачи есть обстоятельства

существенные и несущественные для выбора

целесообразного поведения. Например, когда мы окликаем на

улице по имени своего приятеля, нам безразлично,

видим мы его на фоне белого или серого дома. Нам также

все равно, видим мы его в профиль или анфас. Хотя

ситуации, с точки зрения колбочек сетчатки, и разные, мы

реагируем одним и тем же возгласом: «Коля,

здравствуй!» Наш мозг совершает при этом преобразование

многих разных ситуаций в одно и то же действие

(совершает вырожденное отображение множества ситуаций

на множество реакций).

Однако не всегда ситуации, соответствующие виду

одного и того же человека, требуют одинакового

действия. Когда автор-юморист читает «на пробу» свой

рассказ нескольким людям, его интересует не кто они,

а смеются ли они. Если смеются — рассказ можно

печатать, если нет — нужно переделывать. Решая эту

задачу, мозг тоже совершает вырожденное

отображение, но теперь существенными оказались другие

обстоятельства. При решении третьей задачи существенным

может оказаться лишь расстояние до человека (а не его

имя или настроение); в четвертой задаче важным

окажется— во что человек одет, и т. д.

Процесс выделения существенных (для данной

задачи) обстоятельств можно описать и иначе. Можно

сказать, что мозг разбивает входные ситуации на

классы, обладающие тем свойством, что все ситуации из

одного класса требуют одного и того же действия.

Разделим теперь мысленно процесс преобразования

совокупности входных сигналов в целесообразное

действие (вся деятельность мозга) на два этапа. Первый

этап — разбиение ситуаций на классы, требующие

одинакового (пока безразлично какого) действия. Второй

этап — выбор (синтез) действия, целесообразного для

всей группы ситуаций.

Первый этап принято называть узнаванием. Этому

крупному блоку, входящему в состав мышления, и

посвящена наша книга.

Второй этап (синтез действия) изучен гораздо

меньше. Этот вопрос лишь косвенно затрагивается в главе VI.

Любопытно, однако, что синтез действия, по-видимому, в

свою очередь включает в себя блоки типа «узнавание».

18

§ 3. Интуитивная постановка задачи узнавания

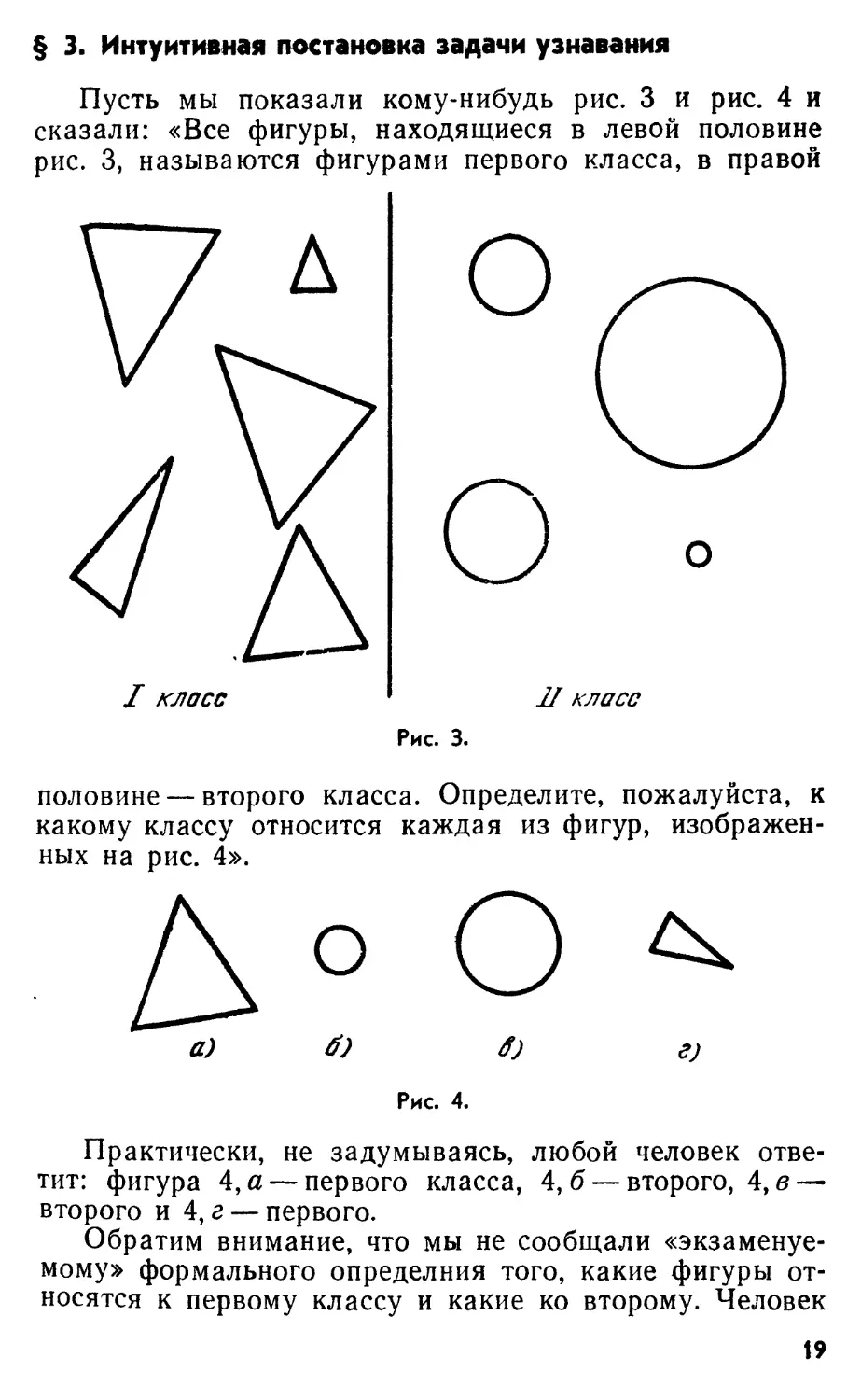

Пусть мы показали кому-нибудь рис. 3 и рис. 4 и

сказали: «Все фигуры, находящиеся в левой половине

рис. 3, называются фигурами первого класса, в правой

/ класс

Л класс

Рис. 3.

половине — второго класса. Определите, пожалуйста, к

какому классу относится каждая из фигур,

изображенных на рис. 4».

а) б) б) г)

Рис. 4.

Практически, не задумываясь, любой человек

ответит: фигура 4, а — первого класса, 4,6 — второго, 4, в —

второго и 4, г — первого.

Обратим внимание, что мы не сообщали

«экзаменуемому» формального определния того, какие фигуры

относятся к первому классу и какие ко второму. Человек

19

сам, пользуясь примерами, данными на рис. 3, создает

гипотезу о принципе разделения на классы. В момент

экзамена человек использует эту гипотезу для

классификации. «Отметка за экзамен» (число правильных

ответов и ошибок) будет зависеть от того, насколько

близка гипотеза к принципу, которым пользовался

составитель задачи.

Иногда называют «узнающим устройством» систему,

которая осуществляет классификацию, пользуясь

некоторым постоянным принципом. Такая система может

очень хорошо решать какую-нибудь одну задачу. Она

все наперед знает об этой задаче и ничему новому не

учится. Примером необучаемой узнающей системы

может служить приемная часть любого монетного

автомата. Она проверяет размеры, вес, материал, из

которого сделана опущенная монета, и узнает монету того

достоинства, на которое рассчитан автомат. Устройство

отличает нужные монеты от фальшивых и от настоящих

монет другого достоинства.

Нас такие системы интересовать не будут. В этой

книге будут рассматриваться только устройства,

предназначенные решать много разных задач. Основным

в работе такого устройства является выяснение вопроса,

с какой задачей оно столкнулось сейчас. Трудность

состоит в том, что сведения о принципе разбиения

объектов на классы устройство получает не в виде

формального определения, а путем наблюдения некоторого

числа примеров (как в задаче па рис. 3 и 4). Мы будем

называть процесс составления принципа классификации,

которая будет использоваться при экзамене, обучением.

Объекты, использованные при обучении, будут

называться материалом обучения, а при экзамене —

материалом экзамена. Везде, где это несущественно, мы

будем для простоты рассматривать примеры, в которых

объекты разбиваются на два класса.

Любопытно, что эволюция животного мира

развивалась и по пути совершенствования специализированных

почти необучаемых систем, и по пути создания систем,

способных обучиться решению весьма разнообразных

задач. Примерами являются насекомые и позвоночные.

Пчелы практически всё умеют от рождения. Они,

конечно, и учатся тоже, но благоприобретенные знания

составляют незначительную часть унаследованных.

20

Человека также многому не надо учить.

Новорожденный ребенок сразу «умеет» дышать, переваривать

пищу, сжимать зрачок глаза под влиянием света и т.п.

Однако в жизни взрослого человека весьма

существенную часть составляет деятельность, которой необходимо

учиться. Без обучения человек не может ни говорить,

ни трудиться, ни даже ходить на двух конечностях.

В отношении всего того, что отличает его поведение от

поведения более примитивных животных, человек

рождается не со знаниями, а со способностью

учиться. Но благодаря этой возможности он

приспосабливается к очень разным задачам.

§ 4. «Творческие» задачи и узнавание

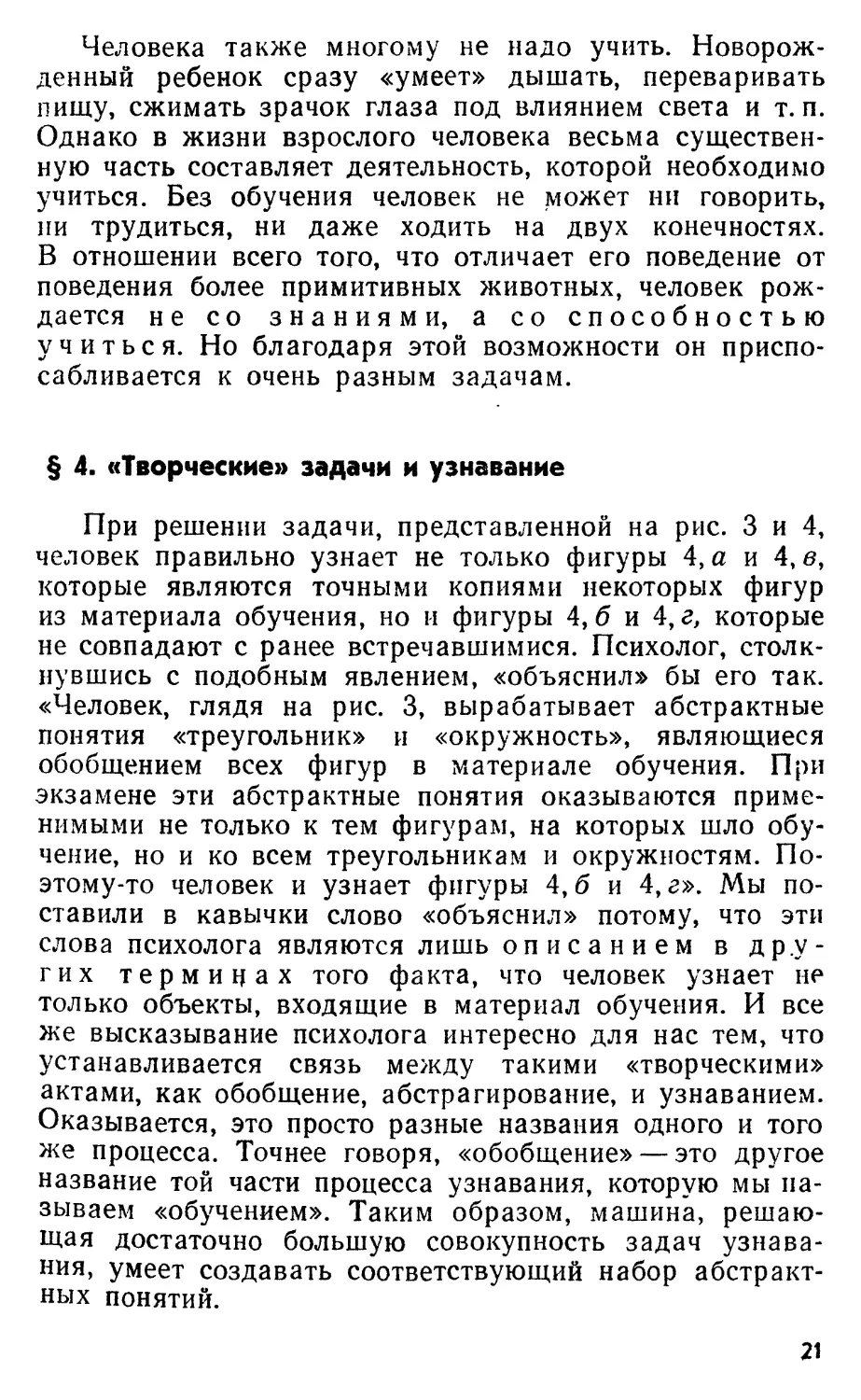

При решении задачи, представленной на рис. 3 и 4,

человек правильно узнает не только фигуры 4, а и 4, в,

которые являются точными копиями некоторых фигур

из материала обучения, но и фигуры 4, б и 4, г, которые

не совпадают с ранее встречавшимися. Психолог,

столкнувшись с подобным явлением, «объяснил» бы его так.

«Человек, глядя на рис. 3, вырабатывает абстрактные

понятия «треугольник» и «окружность», являющиеся

обобщением всех фигур в материале обучения. При

экзамене эти абстрактные понятия оказываются

применимыми не только к тем фигурам, на которых шло

обучение, но и ко всем треугольникам и окружностям.

Поэтому-то человек и узнает фигуры 4,6 и 4, г». Мы

поставили в кавычки слово «объяснил» потому, что эти

слова психолога являются лишь описанием в др.у-

гих терминах того факта, что человек узнает не

только объекты, входящие в материал обучения. И все

же высказывание психолога интересно для нас тем, что

устанавливается связь между такими «творческими»

актами, как обобщение, абстрагирование, и узнаванием.

Оказывается, это просто разные названия одного и того

же процесса. Точнее говоря, «обобщение» — это другое

название той части процесса узнавания, которую мы

называем «обучением». Таким образом, машина,

решающая достаточно большую совокупность задач

узнавания, умеет создавать соответствующий набор

абстрактных понятий.

21

Есть и другая область соприкосновения «творческого

процесса» (например, в работе ученого) и узнавания.

Известно, что многие научные открытия могли быть в

принципе сделаны методом проб и ошибок. В

простейшем случае можно прямо пробовать разные

формулировки закона. Примером может служить открытие

формулы Бальмера (для длины волн линий в спектре

водорода) или третьего закона Кеплера (связь между

периодами обращения планет вокруг Солнца и большими

полуосями орбит). Имея достаточный набор

эмпирических данных и терпеливо пробуя разные формулы,

можно наткнуться на такую, которая достаточно хорошо

описывает весь экспериментальный материал. В более

сложном случае объектами проб могут быть не

формулы, а методы исследования, причем применение

каждого метода часто также требует многих проб. В

результате общее число проб может оказаться слишком

большим.

Если мы понаблюдаем за собой (или другим

человеком) в подобной ситуации, то заметим, что пробе

подвергаются далеко не все известные нам методы решения

различных задач. Мы «с первого взгляда» отбираем те

методы, которые не имеют отношения к задаче, и те

методы, которые дают надежду ее решить. В предельно

утрированной форме один математик выразил эту

мысль так: «Берясь за трудную математическую задачу,

никто не пытается найти решение путем подметания

комнаты». Ясно, что переход от слепого поиска к поиску

«умному» связан с нахождением у данной задачи общих

черт с некоторыми ранее решенными задачами, т. е.

требует узнавания.

В главе I мы постарались показать, что процесс

узнавания играет чрезвычайно важную роль во всей

деятельности мозга, начиная с организации самых

примитивных форм поведения и кончая работой

ученого. В настоящее время имеются доводы за то, что и

синтез действия также содержит несколько этапов

узнавания.

Несмотря на безусловную связь проблемы узнавания

с нейрофизиологией и психологией, рассматривая пути

построения узнающих систем, мы не будем использовать

22

физиологические данные. Основной причиной этого

является малочисленность сведений, имеющих отношение

к интересующему нас вопросу. Таким образом, здесь

мы стремимся осуществить не подход ученого,

исследующего, как природа решила некоторую задачу, а

подход инженера, самостоятельно эту задачу

решающего.

Тем интереснее будет потом сопоставить результаты

таких «инженерных» построений с данными, добытыми

физиологами при изучении в первую очередь

анализаторных структур. Можно надеяться, что подобное

сопоставление позволит более целенаправленно искать те

элементарные операции, с помощью которых в нервной

системе осуществляется узнавание.

Глава II

РАЗЛИЧНЫЕ ПОДХОДЫ

§ 1. Исходное описание объектов

Всякое узнающее устройство получает сведения об

объектах с помощью некоторых датчиков. В принципе

это могут быть произвольные измерительные устройства

(фотоэлементы, микрофоны, термопары, измерители

концентрации некоторых газов и т. п.). По аналогии с

термином, принятым в физиологии, мы будем называть

такие датчики рецепторами. Анализируя свойства

объекта, каждый рецептор выдает некоторое число*).

Набор чисел, появившихся на выходе всех

рецепторов, является той информацией, на основе которой

узнающее устройство будет решать задачу (принимать

решение о принадлежности объекта к тому или иному

классу). Для решения задачи показания рецепторов

каким-то образом перерабатываются. Алгоритм этой

переработки будет зависеть от двух обстоятельств. Во-

первых, от того, какая задача решается, и, во-вторых, от

набора рецепторов, которым обладает узнающее

устройство.

Очевидно, задача, требующая при одном наборе

рецепторов сложной переработки информации, может

оказаться совсем простой при другом наборе. Пусть,

например, требуется определить удельный вес некоторого

кристаллического вещества. Допустим, имеющиеся в

нашем распоряжении рецепторы позволяют измерять

интенсивности рентгеновых лучей, рассеянных кристаллом

под различными углами, и определить химический

состав кристалла. Этих данных часто оказывается доста-

*) Для простоты мы нигде не будем рассматривать случай,

когда объект изменяется во времени (это вызвало бы и изменение

во времени показаний рецептора).

24

точно для определения удельного веса. Однако расчет

получится очень сложным. Придется по результатам

исследований рентгеновыми лучами вычислять структуру

кристаллической решетки. Затем соображать, какие

атомы в каких узлах решетки находятся. А после этого

уже можно найти удельный вес кристалла.

Все становится гораздо проще, если в качестве

рецепторов мы обладаем весами и приспособлением для

измерения объема. В этом случае вся обработка

сигналов от рецепторов будет заключаться в делении одного

числа на другое.

Возникает вопрос: не сводится ли проблема

построения узнающих систем к выбору подходящих

рецепторов? К сожалению, в большинстве случаев набор

рецепторов системы определяется не тем, что было бы

нужно измерить для решения той или другой

задачи, а тем, что удается измерить.

Например, для узнавания окружающих предметов

нам весьма полезно знать коэффициенты отражения их

поверхностей (в том числе и в разных длинах волн).

Для их определения было бы нужно отдельно

измерить интенсивность света, падающего на поверхность, и

интенсивность отраженного света. Однако «по

техническим причинам» (устройство глаза) удается

измерить только отраженный свет. Мозгу приходится

весьма сложным путем, сопоставляя свет, отраженный от

многих мест одного предмета и от многих предметов,

уштывая форму предметов-и т. п., приближенно

определять коэффициент отражения поверхности.

Есть и другое обстоятельство, мешающее заменить

сложную обработку сигналов созданием специальных

рецепторов. Мы ведь рассматриваем системы,

способные решать широкий круг разнообразных задач.

Поэтому, если бы мы пошли по пути подгонки рецепторов под

отдельные задачи, то понадобилось бы слишком много

разных рецепторов. В рассмотренном выше примере

нужен был бы выносной фотоэлемент (для определения

интенсивности света, падающего на предмет). Для

определения расстояния до предметов понадобилось бы что-

то вроде радиолокатора. Чтобы отличить гладкую

поверхность от шероховатой, понадобился бы прибор,

определяющий коэффициенты отражения в разных

направлениях и т. д.

25

Человек решает все эти задачи (и еще великое

множество других), пользуясь одними и теми же

рецепторами сетчатки глаза. Универсальность достигается не

за счет разнообразия типов рецепторов, а за счет

разнообразия алгоритмов обработки сигналов, посылаемых

палочками и колбочками сетчатки. Например, для

определения расстояния до некоторого предмета мозгу

человека приходится сопоставлять между собой сигналы,

приходящие от двух глаз (стереоскопический эффект),

учитывать дымку, принимать во внимание, какой

предмет на какой проектируется, и т. п. В результате мы и

без радиолокатора, пользуясь только двумерными

изображениями на сетчатках, восстанавливаем

пространственное расположение предметов.

Ставя перед собой цель построить узнающую

систему для того или иного круга задач, мы будем всюду

в этой книге считать, что набор рецепторов системы

определен заранее. Например, все системы,

моделирующие зрительный анализатор человека, будут получать

исходную информацию в следующем виде: «поле

зрения» системы разбито на некоторое число участков,

количество света, попадающего на каждый участок,

сообщается системе. Если в качестве узнающей системы

используется универсальная машина, то можно считать,

что рецепторами системы являются те ячейки памяти ма-»

шины, куда введены числа, характеризующие

количество света на разных участках поля зрения.

Итак, мы будем считать, что к моменту начала

работы конструктора узнающей системы (программиста)

исходное описание объектов уже задано. В его власти

только выбрать способ обработки этого исходного

описания. Возможные принципы обработки входной

информации рассматриваются в этой главе.

§ 2. Запоминание материала обучения

Можно попытаться решить задачу узнавания

следующим способом: запомним исходные описания всех

объектов материала обучения (например, фигур на рис. 3)

вместе с указаниями, к какому классу они принадлежат.

При экзамене сравниваем описание неизвестного

объекта с описаниями, запасенными в памяти в ходе

обучения. Если описание неизвестного объекта полностью

26

совпало с описанием некоторого объекта первого

класса, значит он принадлежит к первому классу, аналогии*

но — со вторым классом.

Для системы, работающей по этому принципу,

описание класса треугольников заключается в перечислении

описаний всех когда-либо виденных ею треугольников,

описание класса окружностей — в перечислении

виденных окружностей и т. д.

Очевидно, этим методом можно узнавать лишь те

объекты, которые встречались в материале обучения.

Например, фигуры 4, б и 4, г не были бы узнаны.

Психолог сказал бы, что такая система не

вырабатывает абстрактных понятий. И действительно, чтобы

узнавать новые (не участвовавшие в обучении) объекты,

необходимо найти нечто общее во всех объектах одного

класса. Нужно отвлечься от различий внутри класса и,

наоборот, обратить особое внимание на то, чем

отличается один класс от другого. Всего этого не умеет

делать система, запоминающая исходные описания

объектов.

Мы же заинтересовались узнаванием именно в связи

с желанием промоделировать такие функции, как

«обобщение», «рассуждение по аналогии» и т. п. Поэтому

системы, запоминающие материал обучения, в книге

практически рассматриваться не будут..

§ 3. Поиски близости в пространстве рецепторов

В этом и следующем параграфах будет идти речь о

системах, предназначенных для узнавания плоских

геометрических объектов. Поэтому будем считать, что

сведения об объектах имеют вид некоторого распределения

темных и светлых мест на ограниченном участке

плоскости. Зададимся пространственной разрешающей

способностью системы (грубостью растра изображения).

Тогда описанием объекта является конечный набор

чисел. Если считать, что каждое число является

координатой в многомерном пространстве *) (число измерений

*) Подобно точке на плоскости или в (трехмерном)

координатном пространстве, многомерной (точнее, n-мерной) точкой

называют упорядоченную систему из п чисел. Эти числа называют

координатами соответствующей точки. Совокупность всех

возможных многомерных (м-мерных) точек называют многомерным (п-мер-

21

равно числу участков растра), то объект представляется

некоторой точкой в этом пространстве. Следуя

установившейся традиции, мы будем называть это

пространство пространством рецепторов.

Естественно, нет нужды допускать непрерывные

изменения координат в этом пространстве. Всегда можно

разбить степень светлоты на конечное число уровней.

В большинстве сделанных до настоящего времени

работ авторы пользуются только двумя уровнями («черно-

белые» системы). Такая идеализация вполне допустима

на современном этапе работы, так как при этом

сохраняются многие (хотя и не все) принципиальные

трудности проблемы узнавания геометрических объектов.

Переход к рассмотрению пространства рецепторов

сам по себе не является шагом вперед (это лишь

описание задачи на другом языке). Но после такого

перехода возникает соблазн ввести в пространстве

рецепторов понятие «близости» объектов*).

Конечно, хорошо, если бы удалось так определить

расстояние между точками пространства рецепторов,

чтобы все объекты одного класса оказались близкими

между собой, объекты другого класса — тоже близкими,

а расстояние между объектами различных классов было

бы велико. Разумеется, нужно, чтобы это соотношение

имело бы место для всех интересующих нас задач.

Тогда во время обучения было бы достаточно

приблизительно определить (наблюдая, куда попадают точки из

ным) пространством. Пространство называют метрическим, если в

нем задана числовая функция, которая каждой паре точек

пространства ставит в соответствие расстояние между ними. Эту функцию

называют метрикой пространства Предполагается, что метрика

пространства должна удовлетворять некоторым естественным

условиям. В евклидовом я-мерном пространстве расстояние между

точками Л с координатами (аь #2, •-., an) и В (b\, b2, ..., Ьп)

определяется по формуле

ЛВ = K(a,-*i)2-Ha2-/;2)2+ ... +(аа-Ья)*.

*) Вообще говоря, эта процедура не обязательно определяет

метрику в пространстве рецепторов. Например, расстояния между

точками этого пространства могут не удовлетворять аксиоме

треугольника (расстояние между двумя точками не превосходит суммы

их расстояний до любой третьей. При введении метрики

удовлетворение этой аксиомы считается необходимым). Однако в

большинстве работ рассматриваемого направления вводится некоторая

метрика в пространстве рецепторов.

28

материала обучения) области пространства,

соответствующие разным классам. Дальнейшее — уже дело

вкуса. Можно запомнить границы этих областей и при

экзамене смотреть, куда попадет точка,

соответствующая неизвестному объекту. Можно найти «центры

тяжести» этих областей и при экзамене измерять расстояния

от неизвестной точки до центров тяжести и т. п.

К сожалению, разные задачи предъявляют разные

требования к понятию «близость точек». Для некоторых

задач нужно, чтобы близкими являлись объекты, почти

совпадающие при наложении (имеющие много общих

и мало несовпадающих точек). Для других задач

нужно, чтобы близкими оказались два объекта,

полученных друг из друга путем переноса или поворота. Третьи

задачи потребуют, чтобы близкими в пространстве

рецепторов считались подобные фигуры. Встретится и

задача, в которой будут полезны близость между собой

всех мужских портретов и большое расстояние от них

до всех женских. Существенно, что при этом появятся

и противоречивые требования.

Требование близости между собой всех

окружностей (независимо от диаметра) и удаленности их от

всех треугольников придет в противоречие с

требованием близости между собой всех маленьких

фигур (независимо от формы) и удаленности их от

больших фигур и т. п.

Иногда говорят не о близости точек, относящихся к

разным классам, а об их разделимости в пространстве

рецепторов с помощью гиперплоскостей*) или других

гладких поверхностей. Однако при этом трудность не

исчезает, а лишь маскируется. Дело в том, что точки,

относящиеся к разным классам, оказываются (для

многих задач) очень сильно «перемешанными» в

пространстве рецепторов. Грубо говоря, они расположены как

частицы губки и воды в случае, когда вода

пропитывает губку. Невозможно провести достаточно

гладкую поверхность так, чтобы по одну сторону от нее

была только вода, а по другую — только губка.

*) Гиперплоскостью в /z-мерном пространстве называют

множество таких точек X(xit х2, ..., *п), координаты которых

удовлетворяют уравнению вида A\Xi+А2х2+ .ч+Апхп^В. В частности,

при п~2 гиперплоскостью является прямая, а при rt = 3 — обычная

плоскость.

29

Несмотря на указанную трудность, в некоторых

работах производится разделение классов

непосредственно в пространстве рецепторов. Упомянем систему,

использующую «гипотезу компактности» *), так

называемый алгоритм секущих плоскостей Э. М. Браверма-

на**). В этой системе пространство рецепторов

рассматривается как многомерное евклидово пространство.

Расстояние между точками в нем ***) равно

квадратному корню из суммы квадратов разностей координат

(или, что практически безразлично, какой-нибудь

монотонной функции от этой величины). Разделяющая

поверхность в этом алгоритме состояла из кусков

гиперплоскостей.

Легко заметить, что такая метрика хороша лишь в

том случае, если по условию задачи нам

целесообразно считать близкими фигуры, имеющие мало

несовпадающих точек (почти тождественные). И, действительно,

программой Бравермана был получен хороший

результат на таких объектах: растр из 60 элементов (6X10).

На этом растре нарисованы цифры, удовлетворяющие

следующим условиям: цифра

должна касаться и верхнего и

нижнего краев растра (быть

стандартной высоты) и быть

центрированной по горизонтали.

Неудивительно, что при соблюдении

этих условий цифры,

принадлежащие к одному классу (двойки,

Рис. 5. В пространстве четверки и т. п.), имеют много

рецепторов цифра 3 общих ТОЧеК.

ближе к одной из дво- Однако, если взглянуть на

ек, чем двойки между \j ' J

собой. Рис- 5, то легко заметить, что в

пространстве рецепторов цифра 2

в левом верхнем углу поля зрения будет гораздо

«ближе» к цифре 3, чем к двойке в правом нижнем углу.

Поэтому описываемая система не может узнавать,

например, цифры произвольных размеров и произвольно

расположенные на растре (в поле зрения машины).

*) Компактность не в математическом смысле.

**), См. А. Г. Аркадьев и Э. М. Браверман, Обучение

машины распознаванию образов, «Наука», М., 1964.

***) См. подстрочное примечание на стр. 27.

30

Вопреки изложенной ситуации, «гипотеза

компактности» предполагает, что таких «плохих» взаимных

расположений классов в пространстве рецепторов

практически не бывает*). А если и случится такое

«перемешивание» точек, относящихся к разным классам, то задача

становится неразрешимой никаким устройством. Как же

быть со случаем, изображенным на рис. 5? Точки

перемешаны, а существует система (человек!), прекрасно

решающая задачу? Сторонники гипотезы компактности

отвечают так: действительно, есть некоторые

преобразования фигур (например, параллельный перенос), при ко-»

торых фигуры остаются очень похожими для человека,

но находятся на большом расстоянии в пространстве

рецепторов. Однако таких преобразований мало —

перенос, поворот, подобное преобразование — и все.

Давайте заранее совершим все эти преобразования:

перенесем фигуру в центр растра, доведем ее размеры до

стандартной величины и повернем ее в стандартное по-*

ложение, — вот тогда все станет (в пространстве

рецепторов) «компактным».

В отношении цифр это верно. Но существует множе-»

ство задач, которые не могут быть решены указанным

способом. Приведем несколько примеров.

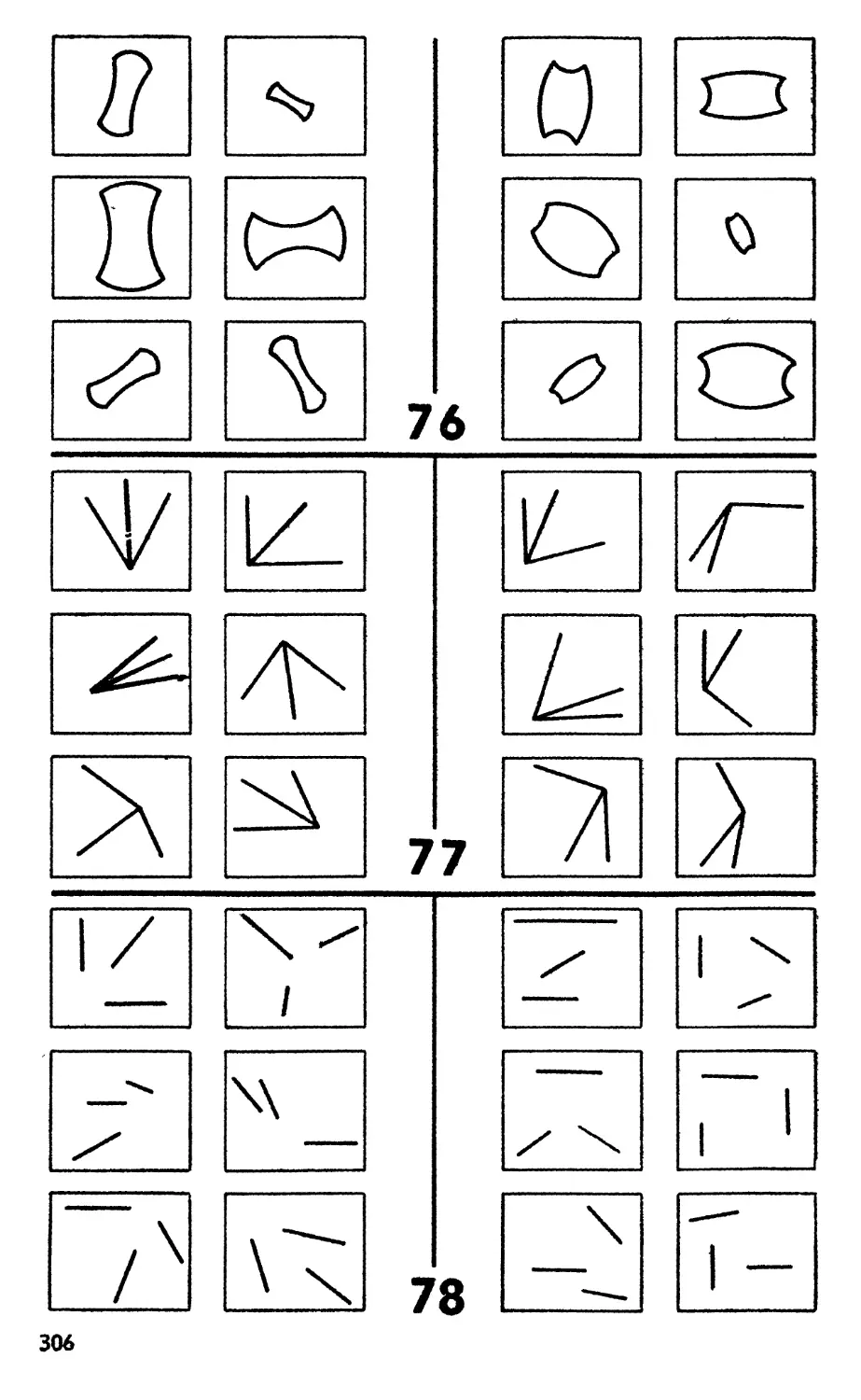

На рис. 6, 7 и 8 показаны разные задачи. На левой

половине каждого рисунка даны примеры объектов

одного класса, на правых — другого.

Человек, посмотрев на рис. 6, быстро замечает, что

первый класс от второго отличается формой

внутренней фигуры. Если внутренняя фигура — треугольник,

значит объект принадлежит второму классу, если

прямоугольник— первому. Попробуем решить задачу

«методом приведения к компактному виду». Для этого нам

нужно поместить на одно и то же место растра, довести

до стандартного размера и повернуть в стандартное

положение... не всю фигуру, а лишь ее внутреннюю часть.

Именно после такого преобразования все объекты пер^

вого класса легко отделятся (например,

гиперплоскостью) от объектов второго класса. Трудность, однако,

в том, что система «не знает», какие части фигур нужно

*) Термин «компактность» возник именно от предположения, что

точки, соответствующие одному классу, расположены в

пространстве рецепторов кучно («компактно»),.

31

приводить в стандартное положение. Для того чтобы

осуществить необходимое преобразование, система

должна заранее знать, чем различаются классы.

Получился порочный круг.

//гласе

В класс

Рис. 6.

I ила ее

Лпласс

Рис. 7.

В задаче, поставленной на рис. 6, невозможно

отыскать хорошее преобразование объектов, но

такое преобразование все-таки существует. Для задач,

показанных на рис. 7 и 8, «хороших» (в указанном смысле)

преобразований просто нет. Как ни меняй масштаб, как

ни поворачивай фигуры и ни передвигай их по растру,

32

все равно в пространстве рецепторов всевозможные

многоугольники не соберутся в область, которая легко

отделится от области всех криволинейных фигур (рис. 7).

То же самое относится и к задаче на рис. 8. В

пространстве рецепторов выпуклые и невыпуклые фигуры не

образуют компактных областей, и никакими заранее

предписанными сдвигами, поворотами и растяжениями дела

не поправить.

Человек решает подобные задачи с легкостью. И это

непосредственно опровергает исходные позиции

гипотезы компактности. Оказывается, можно решать задачи

(класс

Д класс

Рис. 8.

(и весьма разнообразные), в которых классы плохо

разделяются в пространстве рецепторов. Слово плохо

в предыдущей фразе означает, что точки, относящиеся

к разным классам, не удается отделить друг от друга

плоскостью или некоторой поверхностью, для

геометрического*) описания которой понадобится

значительно меньше параметров, чем существует объектов в

каждом классе.

Итак, мы пришли к выводу о безнадежности поиска

близости в пространстве рецепторов для широкого круга

задач.

*) Речь идет об описании разделяющей поверхности в

терминах ее геометрических свойств потому, что если никак

не ограничить допустимые описания, то придется считать описанием,

например, и такую фразу: «Поверхность, отделяющая все точки,

соответствующие многоугольникам, от точек, соответствующих

криволинейным фигурам».

33

§ 4. Стандартное (не зависящее от конкретной задачи)

преобразование пространства рецепторов. Перцептрон

Лоле рецепт ороЗ

Ассоциот Усилители Решающее

элементы устройство

Рис. 9. Схема перцептрона. Изображение объекта при

обучении и экзамене проектируется на поле рецепторов S.

Каждый рецептор в зависимости от того, попало на него

белое или черное место картинки, может перейти в состояния

О или 1. Все рецепторы соединены (для простоты на схеме

показано лишь несколько соединений) с ассоциативными

элементами (Ai,...,An) связями, которые могут быть

«возбуждающими» (И-) и «тормозящими» (—). Возбуждающая

связь в зависимости от состояния рецептора передает

сигнал, равный 0 или +1, а тормозящая 0 или —1. Каждый

А-элемент суммирует все приходящие к нему сигналы. Если

эта сумма превосходит некоторый порог, то А-элемент

возбуждается. Система связей А-элементов и их пороги

возбуждения выбираются заранее (например, с помощью жребия).

Они не меняются ни при решении какой-либо задачи, ни при

переходе от одной задачи к другой. Если А-элемент не

возбужден, то он не посылает никакого сигнала. Возбужденные

А-элементы посылают в решающее устройство (сумматор) R

сигналы через усилители, которые могут изменять как

величину, так и полярность (знак) сигналов. До начала обучения

коэффициенты усиления к всех усилителей равны нулю. На

рисунке черные кружки условно изображают

невозбужденные рецепторы, а белые — возбужденные. Сигналы в

ассоциативные элементы приходят только от возбужденных

рецепторов (обозначены 4-1 и —1). Знаки ( + ) и (—)

соответствуют «возбуждающим» и «тормозящим» связям, по

которым в данный момент сигналы не идут.

небольшом числе интересующих нас задач. Естественно

возникает вопрос: нельзя ли так преобразовать про-

М

В предыдущем параграфе было указано, что классы

легко разделяются в пространстве рецепторов лишь в

странство рецепторов в некоторое другое пространство,

чтобы в этом новом пространстве легко разделялись

классы для большей части интересных задач?

По-видимому, первой работой в этом направлении

было создание «перцептрона» *). В настоящее время

есть тенденция любые обучаемые узнающие системы

называть перцептронами. Нам это кажется неудобным, и

в нашей книге перцептроном будет называться только

первоначальная конструкция Розенблатта.

Перцептрон (см. рис. 9) состоит из элементов трех

типов, которые мы будем называть S-элементами, Л-

элементами и /^-элементом. S-элементы являются

рецепторами. Рецепторы соединены с Л-элементами с

помощью связей, которые могут быть возбуждающими или

тормозящими. Каждый рецептор может находиться в

одном из двух состояний, которые можно обозначить

нулем или единицей. Возбуждающая связь передает

Л-элементу состояние рецептора без изменения,

тормозящая связь изменяет знак сигнала. Л-элементы (ассо*

циативные элементы) перцептрона являются

сумматорами с порогом. Каждый Л-элемент возбуждается, если

сумма пришедших к нему от рецепторов по связям

сигналов превосходит некоторый порог. Сигнал от

возбудившихся А-элементов передается в сумматор R, причем

сигнал от элемента Лг- передается с коэффициентом k{.

Система связей всех Л-элементов и их пороги

выбираются заранее (например, некоторым случайным

образом) и в дальнейшем не изменяются ни при

решении какой-либо задачи, ни при переходе от одной

задачи к другой.

Обучение заключается только в выборе

коэффициентов k{. Этот процесс идет, например**), следующим

образом: сначала принимаем все коэффициенты k

равными нулю. Затем перцептрочу «показывают» объект

первого класса. Некоторые Л-элементы при этом

возбудятся; коэффициенты 6, соответствующие этим Л-эле-

ментам, увеличиваем на 1. Потом «показываем» объект

*) Наиболее подробно перцептроны описаны в вышедшей

недавно в русском переводе книге Ф. Розенблатта. Принципы ней-

родинамики (перцептроны и теория механизмов мозга), «Мир», 1965.

**) Мы рассматриваем для простоты так называемый а-пер-

Цептрон. В рамках данного вопроса другие схемы обучения перцеп-

тронов не имеют принципиального отличия.

35

второго класса и коэффициенты, соответствующие

возбудившимся теперь Л-элементам, уменьшаем на 1.

Продолжаем процесс до исчерпания всего материала

обучения. В результате обучения сформировались

коэффициенты к, которые будут использованы при экзамене.

Во время экзамена перцептрону «показывают»

неизвестный объект. Возбудившиеся Л-элементы подают в

R сигнал, равный соответствующим коэффициентам k.

Если сумма этих сигналов положительна, то

принимается решение, что показанный объект принадлежит к

первому классу, если отрицательна — то ко второму.

Можно считать состояния (0 или 1) Л-элементов

координатами точек «-мерного пространства*) (Л-про-

странство). Тогда система связей и порогов Л-элемен-

тов задает некоторое фиксированное (для данного

перцептроиа) преобразование пространства рецепторов

в Л-пространство **). Совокупность коэффициентов k

задает в Л-пространстве некоторую (п—1)-мерную

гиперплоскость, проходящую через начало координат.

Таким образом, общая схема работы перцептрона такова:

сначала производится некоторое стандартное, не завися*

щее от задачи, преобразование пространства

рецепторов в Л-пространство. Затем с помощью обучения

ищется в Л-пространстве гиперплоскость, отделяющая

объекты одного класса от объектов другого.

Попытаемся представить себе смысл этих операций

и соответственно понять возможности перцептрона.

Допустим вначале, что все Л-элементы имеют

только по одной возбуждающей связи и не имеют

тормозящих связей. Пусть порог каждого из них равен 1 (в

этом случае каждый Л-элемент просто повторяет

реакцию некоторого S-элемента). Каков смысл

образовавшихся к концу обучения коэффициентов А? Очевидно,

модуль ki показывает, насколько чаще встречалась

некоторая точка на растре в картинках одного класса,

чем в картинках другого. Знак ki показывает, в каком

классе (первом или втором) эта точка встречалась чаще.

При экзамене перцептрон проверяет, из каких точек

состоит неизвестная картинка. Если из таких, которые

*) п — число Л-элементов.

**) Преобразование однозначное, но не обязательно взаимно

однозначное.

36

чаще входили в картинки первого класса, значит она и

сама принадлежит первому классу. Ограниченность

возможностей такой системы не нуждается в пояснениях.

Допустим теперь, что все Л-элементы имеют по две

связи, причем обе положительны. Пороги равны 2.

Теперь в kt накапливается информация о частоте

появления сочетания каких-то двух точек на растре. По

каким парам точек ведется учет — задано раз и

навсегда конструкцией перцептрона (связями Л-элементов).

При экзамене «голосование» будет происходить по тем

парам точек, которые встретятся в неизвестной картинке.

В общем случае в k{ накапливается информация о

числе картинок, в которых встретился некоторый

фрагмент из возбужденных и невозбужденных S-элементов.

При низких порогах элемент А{ может срабатывать на

несколько разных фрагментов. Соответственно в k\

будет фиксироваться число появлений хотя бы одного из

этих фрагментов.

Теперь понятно, что для перцептрона должны быть

доступны лишь те задачи, в которых объекты каждого

класса имеют много общих фрагментов. «Сходство» для

перцептрона есть сходство при наложении картинок друг

на друга. Совпадения считаются не по точкам, а пс

фрагментам (точнее, по группам фрагментов, на

которые срабатывают Л-элементы). Естественно ожидать,

что для перцептрона окажутся недоступными

обобщения типа переноса фигуры или подобного

преобразования.

Сам Розенблатт не описал задач, которые оказались

для перцептрона «трудными». Поиск таких примеров

был произведен А. П. Петровым*). Опыты велись на

растре размером 16X16. В разных вариантах перцеп-

трон имел от 400 до 1300 Л-элементов. Число связей**)

каждого Л-элемента менялось от 5 до 30. Поскольку

результаты практически не зависели от этих

параметров, приводятся результаты одного из вариантов; их

можно считать относящимися к любому трехслойному

перцептрону.

1-я задача. Требовалось научиться отличать

прямоугольники, вытянутые в горизонтальном направлении,

*) А. П. Петров, О возможностях перцептрона, Известия

АН СССР, Техническая кибернетика. № 6, 1964,

**) Возбуждающих вместе с тормозящими.

37

от прямоугольников, вытянутых в вертикальном

направлении. (Подобный опыт делал и Розенблатт.) После

показа 15 фигур каждого класса при экзамене на 30

фигурах перцептрон дал 6% ошибок. Результат, в общем,

удовлетворительный.

2-я задача. Требовалось научиться отличать

треугольники от окружностей. Те и другие были

произвольных размеров и произвольно расположены на растре.

Даже после обучения на 45 фигурах каждого класса

перцептрон сделал при экзамене 33% ошибок. Эта

задача для перцептрона недоступна.

3-я задача. Требовалось отличать прямоугольники

от эллипсов. Те и другие произвольно повернуты и

расположены. После обучения на 45 фигурах каждого типа

перцептрон делал при экзамене 50% ошибок!

Возникает вопрос: каким образом перцептрон смог

удовлетворительно решить первую задачу? Ведь и в ней

прямоугольники были разных размеров и по-разному

расположены. Вспомним, однако, что весь растр имел

всего 16 вертикалей и 16 горизонталей. Поэтому при

«любом» расположении, скажем, вертикально

ориентированный прямоугольник неизбежно имел много общих

фрагментов с некоторыми фигурами из материала

обучения. Из-за малости растра при обучении были

показаны хотя и не все возможные фигуры, но почти все

возможные фрагменты. Их-то и запомнил перцептрон*).

Аналогичное обстоятельство, вероятно, помогло перцеп-

трону найти общие фрагменты (куски прямых) во

второй задаче и удержать количество ошибок на уровне,

меньшем 50%. На большем растре (например, ЮОх

X 100) перцептрон не смог бы научиться (при том же

материале обучения) и решению первой задачи.

Мы видим, что переход от пространства рецепторов

к Л-пространству мало помог делу. В Л-пространстве

тоже не выполняется соотношение компактности точек,

*) Заметим, что объем памяти при 1300Л-элементах в принципе

достаточен для запоминания практически всего материала обучения.

Действительно, для одной картинки нужна емкость 256 бит, для

30 картинок ~7500 бит. С другой стороны, 1300 элементов должны

иметь емкость около 5 бит каждый (для записи чисел от —15 до

.+ 15), что составляет ~6500 бит. (Бит или двоичная единица —

единица количества информации. Бит соответствует количеству

информации, достаточному для выбора одной из двух

равновероятных возможностей. \

38

относящихся к объектам одного класса ( для достаточно

разнообразных задач). Поэтому для многих задач

поиски плоскости, делящей классы в Л-пространстве,

обречены на неудачу. Не потому, что мы плохо ищем

(учимся), а потому, что такой плоскости нет. Для перцептро-

на цифра 3 (на рис. 5) «ближе» к одной из двоек, чем

разные двойки между собой.

Перцептрон — система, осуществляющая стандартное

преобразование пространства рецепторов, — мало

приближает нас к решению проблемы узнавания.

§ 5. Переменное (различное для разных задач)

преобразование пространства рецепторов

Вернемся к задаче, представленной на рис. 6. Поче*

му она оказалась трудной для системы, ищущей

близость в пространстве рецепторов (и для перцептрона

тоже)? Одна из причин заключается в том, что

картинки на рис. 6 содержат много лишней

информации. Действительно, каждая картинка несет

информацию о том, является наружная фигура выпуклой или

вогнутой, большой или маленькой, где по отношению к

наружной фигуре расположена внутренняя и т. д. Все

эти сведения для решения данной задачи не

нужны.

В результате обучения система должна перестать

обращать внимание на несущественные

обстоятельства. Это значит, что будет найден

такой метод отображения картинок, при котором л,иш-

няя информация утеряется.

Как ни парадоксально это звучит, но основная

задача узнающей системы (в противоположность задаче

линии связи) вовсе не в сохранении всей информации, а в

максимальном сокращении несущественной информации

о каждом объекте. С этой точки зрения всякое преобра^

зование входных данных, дающее надежду на успех,

Должно быть вырожденным.

На это можно возразить: «конечно, для решения

задачи, предложенной на рис. 6, полезно иметь

преобразователь (фильтр), который пропустит только

внутреннюю фигуру и задержит внешнюю. Однако для

Других задач этот фильтр может оказаться не только

бесполезным, но и вредным (выбросит существенную

39

информацию). Для других задач нужны другие выро*

жденные отображения, и заранее неизвестно, какое

именно отображение полезно для данной задачи».

Возражение это справедливо, но вспомним, что мы

рассматриваем системы, которые и не должны

заранее (до обучения) знать, какие преобразования

полезны для данной задачи. Достаточно, если в ходе

обучения (например, путем проб и ошибок) система найдет

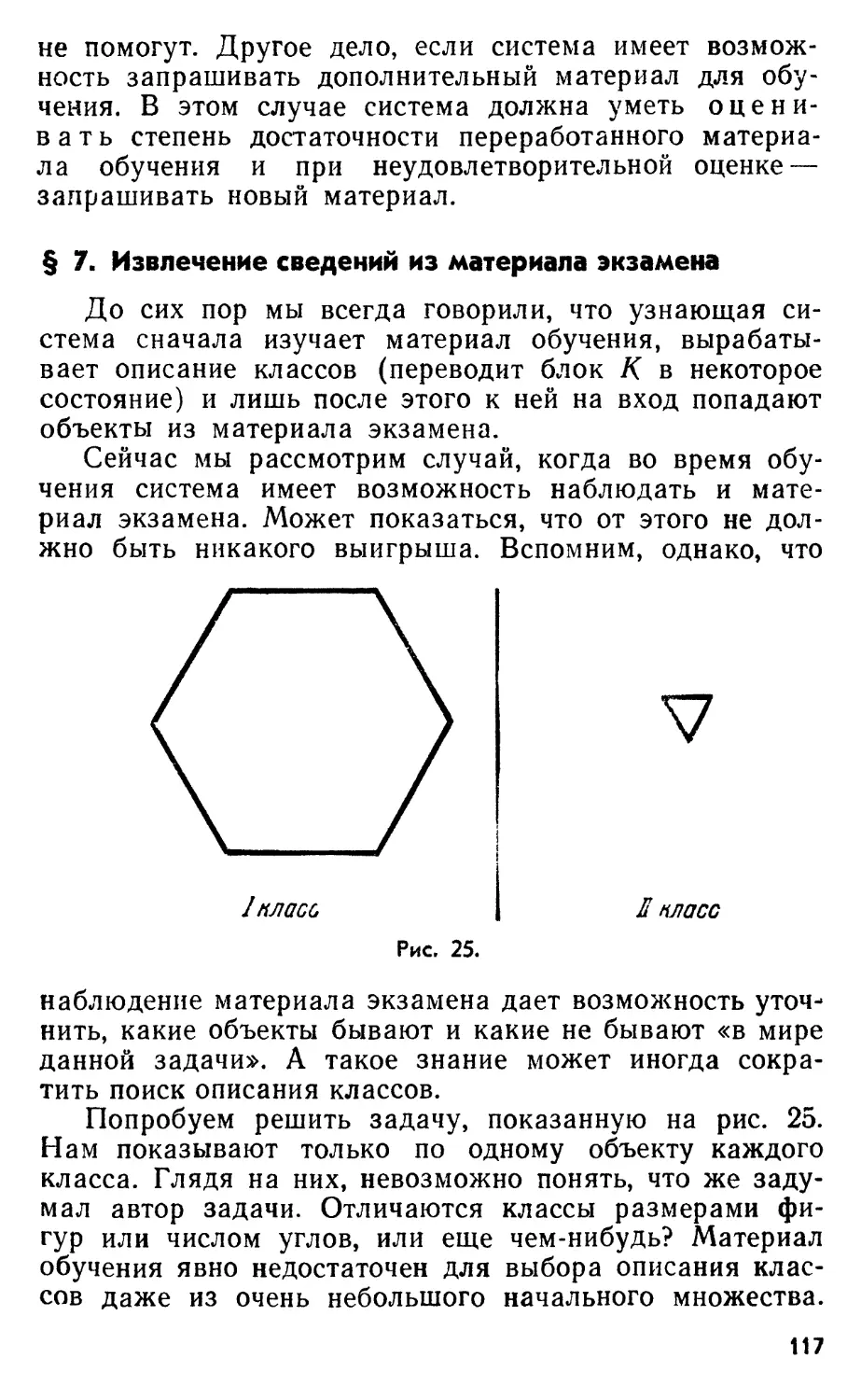

вырожденное отображение, помогающее разделить