Текст

А. А. ФЕЛЬДБАУМ

ОСНОВЫ ТЕОРИИ

ОПТИМАЛЬНЫХ

АВТОМАТИЧЕСКИХ

СИСТЕМ

Ш\

ГОСУДАРСТВЕННОЕ ИЗДАТЕЛЬСТВО

ФИЗИКО-МАТЕМАТИЧЕСКОЙ ЛИТЕРАТ У РЫ

МОСКВА 1963

6П2. 15

Ф39

УДК 62-505

Александр Аронович Фельдбаум

Основы теории оптимальных автоматических систем

М., Физматгиз, 1963 г., 552 стр. с илл.

Редакторы В. Н. Новосельцев, Р. Ш. Рутман.

Техн. редактор Н. Я. Мурашова. Корректор А. Д. Халанская.

Сдано в набор 3/VI 1963 г. Подписано к печати 24/Х 1963 г.

Бумага 84хЮ8/з2. Физ. печ. л. 17,25. Условн. печ. л. 28,29.

Уч.-изд. л. 27,73. Тираж 7 000 экз. Т-13942. Цена книги 1 р. 59 к.

Заказ № 852.

Государственное издательство физико-математической литературы.

Москва, В-71, Ленинский проспект, 15.

Московская типография № 5 Мосгорсовнархоза.

Москва, Трехпрудный пер., 9.

ОГЛАВЛЕНИЕ

Предисловие 5

Глава I. Проблема оптимальной системы 7

§ 1. Значение теории оптимальных систем 7

§ 2. Классификация оптимальных систем 16

§ 3. Критерии оптимальности 27

§ 4. Ввод информации об управляемом объекте в

управляющее устройство 36

§ 5. Постановка задач теории оптимальных систем . . 46

Глава П. Математические методы, применяемые в

теории оптимальных систем 55

§ 1. Некоторые сведения из теории вероятностей . . 55

§ 2. Вариационные методы 81

§ 3. Динамическое программирование 100

§ 4. Принцип максимума 118

Глава III. Оптимальные системы с полной информацией

об управляемом объекте 151

§ 1. Задача о максимальном быстродействии; метод

фазового пространства 151

§ 2. Применение классических вариационных методов 187

§ 3. Применение метода динамического

программирования 209

§ 4. Применение принципа максимума 233

Глава IV. Оптимальные системы с максимальной

неполной информацией об управляемом объекте 247

§ 1. Непрерывные системы с максимальной

информацией об объекте 247

§ 2. Дискретно-непрерывные и чисто дискретные

системы с максимальной информацией об объекте 270

Глава V. Оптимальные системы с независимым

(пассивным) накоплением информации об объекте .... 300

§ 1. Основные задачи теории оптимальных систем с

независимым накоплением информации 300

§ 2. Теория двуальтернативных решений 327

1*

4 ОГЛАВЛЕНИЕ

§ 3. Элементы общей теории статистических решений 351

§ 4. Теория статистических решений в применении к

системам автоматического управления 365

Глава VI. Оптимальные системы с активным

накоплением информации 399

§ 1. Постановка простейшей задачи об оптимальной

системе дуального управления 399

§ 2. Решение задачи и простейшие примеры 414

§ 3. Примеры неприводимых систем 433

§ 4. Обобщение на задачи с инерционными объектами 452

§ 5. Обобщение на задачи с марковскими объектами 476

§ 6. О структурных схемах оптимальных

управляющих устройств 494

Заключение 521

Библиография 531

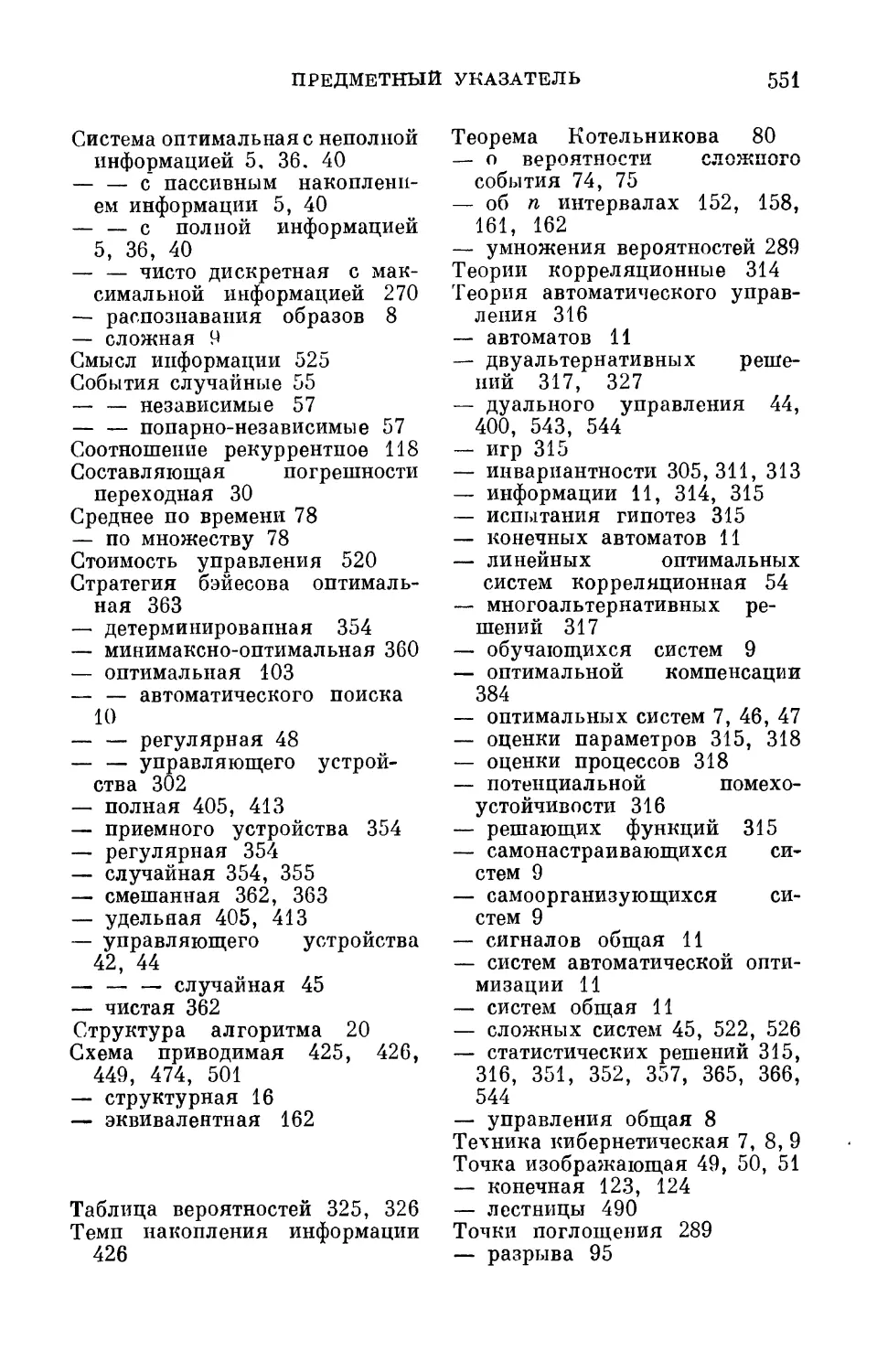

Предметный указатель 546

ПРЕДИСЛОВИЕ

Бурное развитие различных ветвей теории

оптимальных автоматических систем сделало своевременной

попытку охватить с некоторой единой точки зрения основные

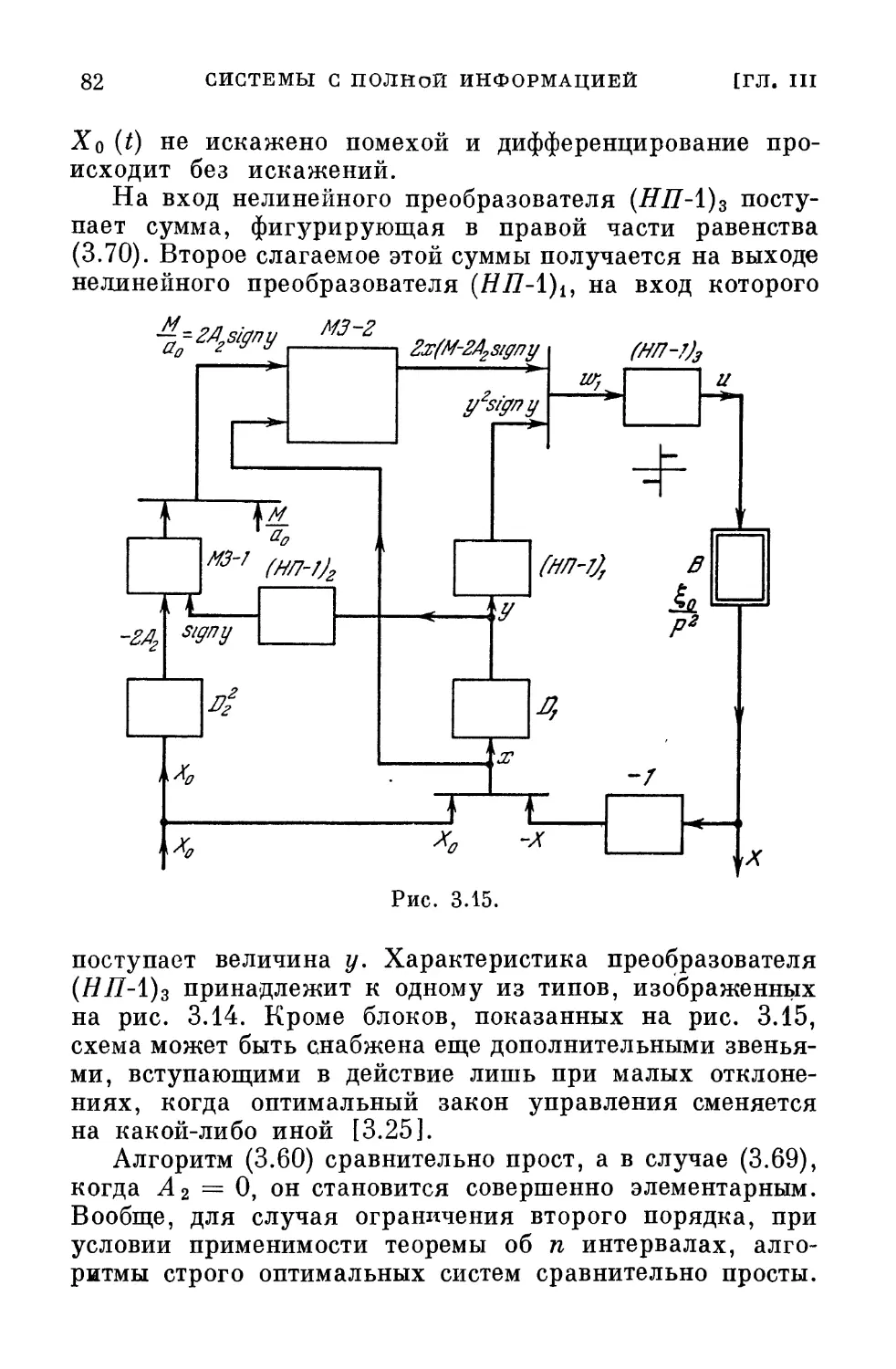

аспекты этой теории. Такая попытка была предпринята

автором в главе «Оптимальные системы», вошедшей в

сборник «Disciplines and techniques of Systems Control» под

редакцией д-ра Пэшона (Люксембург), а также в курсе

лекций, прочитанных в 1961/62 г. аспирантам и сотрудникам

Института автоматики и телемеханики. Изложенная там

точка зрения положена и в основу данной книги. Она

определила последовательность изложения. Вся книга

разделена на шесть глав. В первой главе дается постановка

проблемы, во второй — обзор математического аппарата,

применяемого при ее решении. Третья глава посвящена

так называемым системам с полной, а четвертая — с

максимальной, но неполной информацией об управляемом

объекте. В пятой главе рассматривается теория систем с

неполной информацией об объекте и с пассивным ее

накоплением. Наконец, в шестой главе изучаются системы

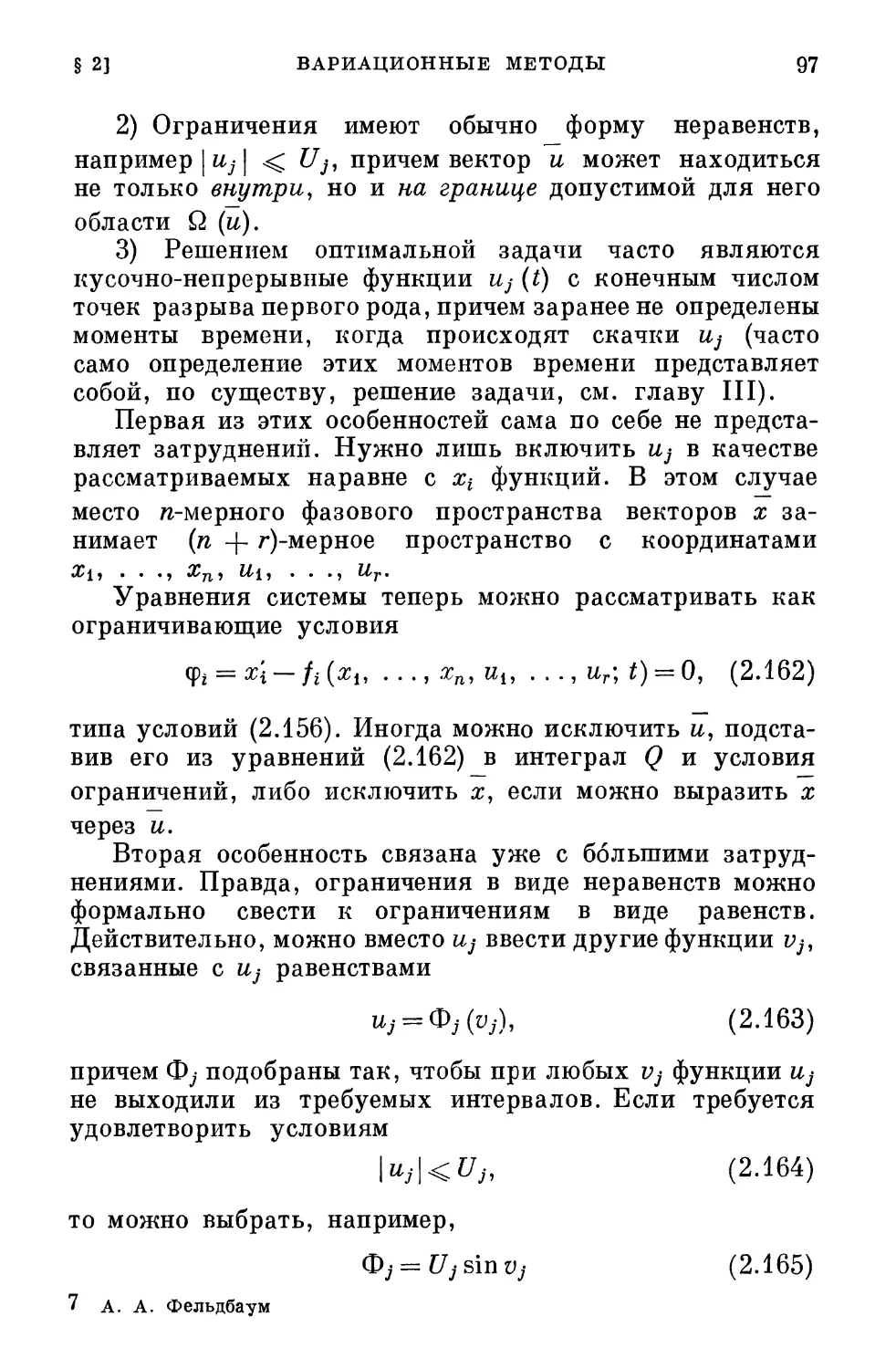

с активным накоплением информации.

Углубление в детали разветвлений теории потребовало

бы чрезмерного увеличения объема книги. Поэтому автор

старался ограничиться лишь основными положениями

теории и иллюстрирующими ее примерами. Приведены

лишь минимально необходимые для изучающего сведения

о математическом аппарате, притом на уровне

«инженерной» строгости.

Книга в целом является теоретической, однако она

написана, согласно распространенному выражению,

«инженером для инженеров».

6 ПРЕДИСЛОВИЕ

В книге не нашли места некоторые весьма важные

направления, в частности, теория Колмогорова — Винера

и труды, ее развивающие, так как в этой области

имеется обширная литература.

Автор считает своим приятным долгом поблагодарить

Я. 3. Цыпкина и А. Г. Бутковского за обсуждение ряда

пунктов, А. В. Храмого за помощь при составлении

библиографии и уточнении дат и К. Маньчака, Р. С. Рутма-

на, В. Н. Новосельцева, Е. П. Маслова, В. П. Живогля-

дова, И. В. Тиме за большую помощь при оформлении

рукописи и редактировании книги.

14 августа 1962 г. А. А. Фелъдбаум

ГЛАВА I

ПРОБЛЕМА ОПТИМАЛЬНОЙ СИСТЕМЫ

§ 1. Значение теории оптимальных систем

Техника передачи и переработки информации —

сокращенно, кибернетическая техника — растет за

последние годы исключительно быстрыми темпами. Развитие

ее важнейшего направления — автоматики —

характеризуется быстрым распространением автоматических

систем, расширением области их применения. Однако

автоматика растет не только «вширь», но и «вглубь».

Появляются новые принципы автоматического управления,

новые типы систем, решающих все более сложные задачи

управления и заменяющих человека во все более сложных

сферах его деятельности.

Системы автоматического управления усложняются.

В простых ранних типах автоматических регуляторов

измерительный, управляющий и исполнительный блоки

часто объединялись. В сложных современных системах

автоматического управления эти блоки представляют

собой, большей частью, отдельные, иногда весьма сложные

устройства. Центральная часть системы — управляющий

блок — нередко выполняется в виде управляющей

машины непрерывного или дискретного действия. В эту машину

закладывается определенный закон или, как его иначе

называют, алгоритм управления. В современных

управляющих машинах универсального или

специализированных типов можно реализовать сложнейшие алгоритмы.

В настоящее время вычислительная техника позволяет

достичь скорости вычислений порядка сотен тысяч и

миллионов элементарных операций в секунду. Поэтому для

8 ПРОБЛЕМА ОПТИМАЛЬНОЙ СИСТЕМЫ [ГЛ, I

многих применений управляющее устройство можно

считать безынерционным.

Аналогичные тенденции проявляются и в других

областях кибернетической техники. Проблемы

сверхдальней связи, телеизмерения и телеуправления,

выделения радиолокационных и телевизионных изображений

на фоне естественных или искусственных помех,

вопросы распознавания образов тесно связаны с реализацией

сложных алгоритмов переработки информации.

Типичный пример устройств этого рода представляют собой

системы распознавания образов. Устройства этого типа

нашли пока применение в основном для распознавания

печатных и написанных от руки букв и цифр,

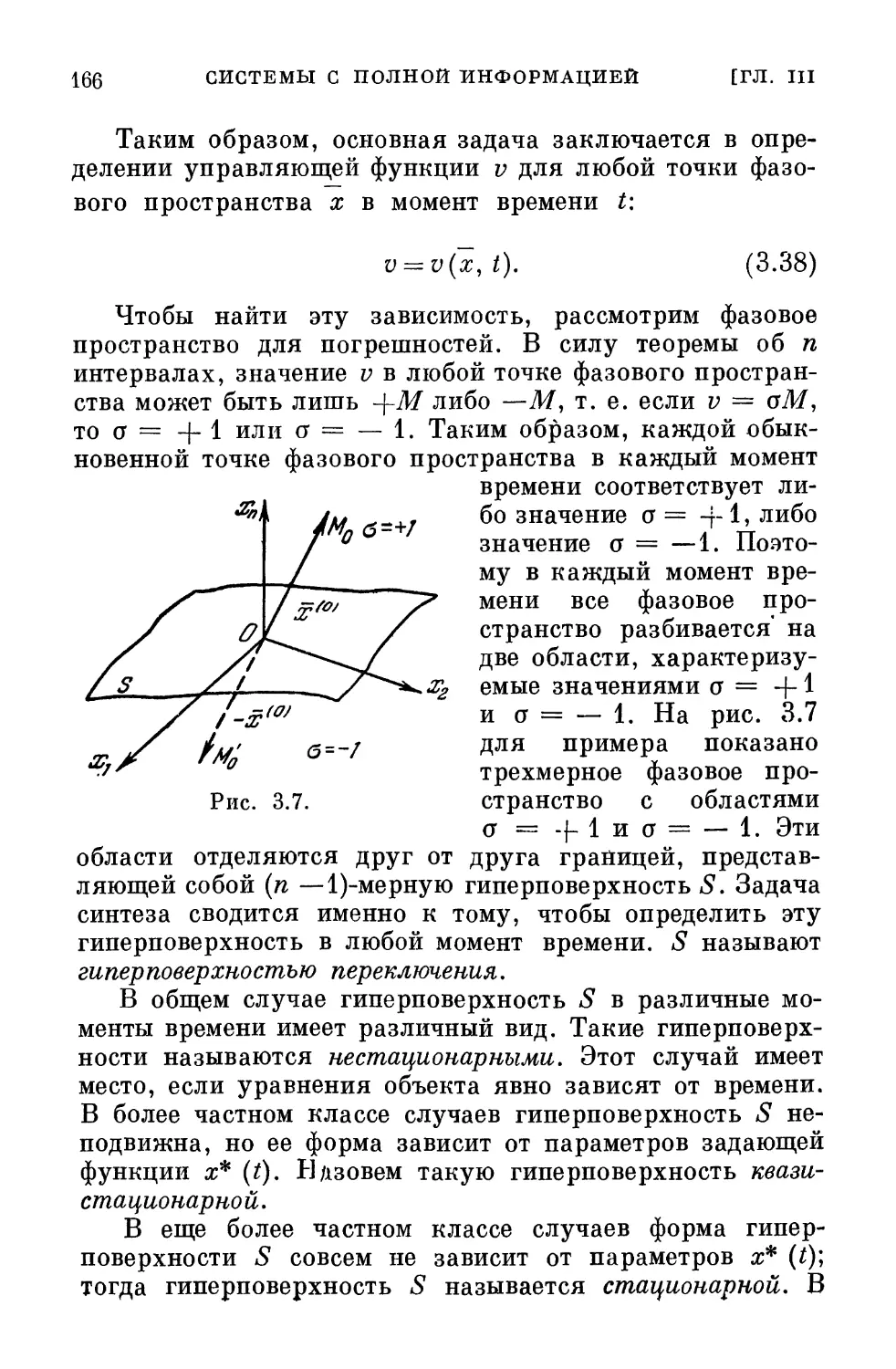

поступающих, например, в вычислительные машины, а также

для распознавания команд, отдаваемых человеком машине

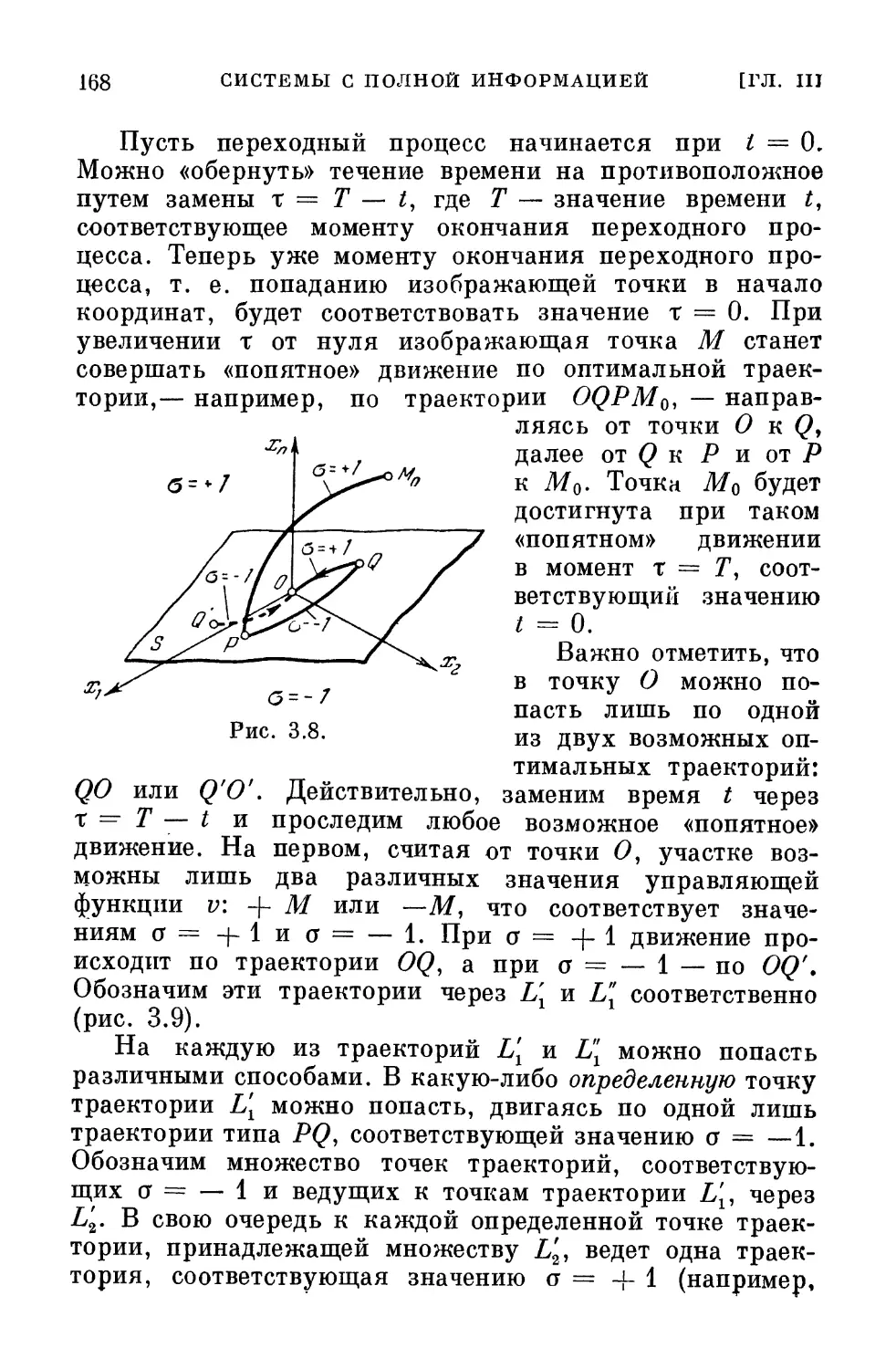

в виде устной речи. Однако перспективы таких устройств

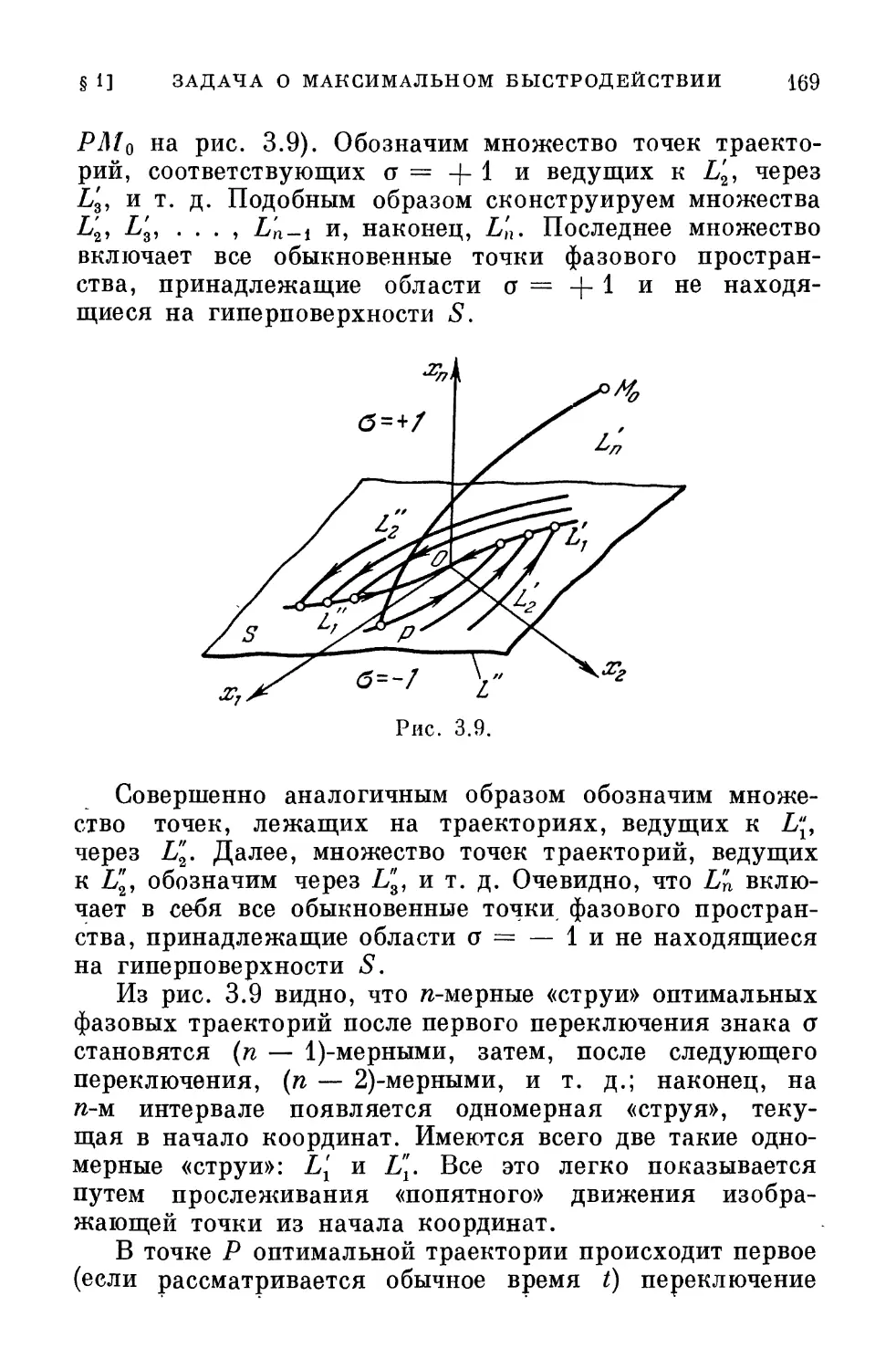

чрезвычайно широки; именно распознавание и

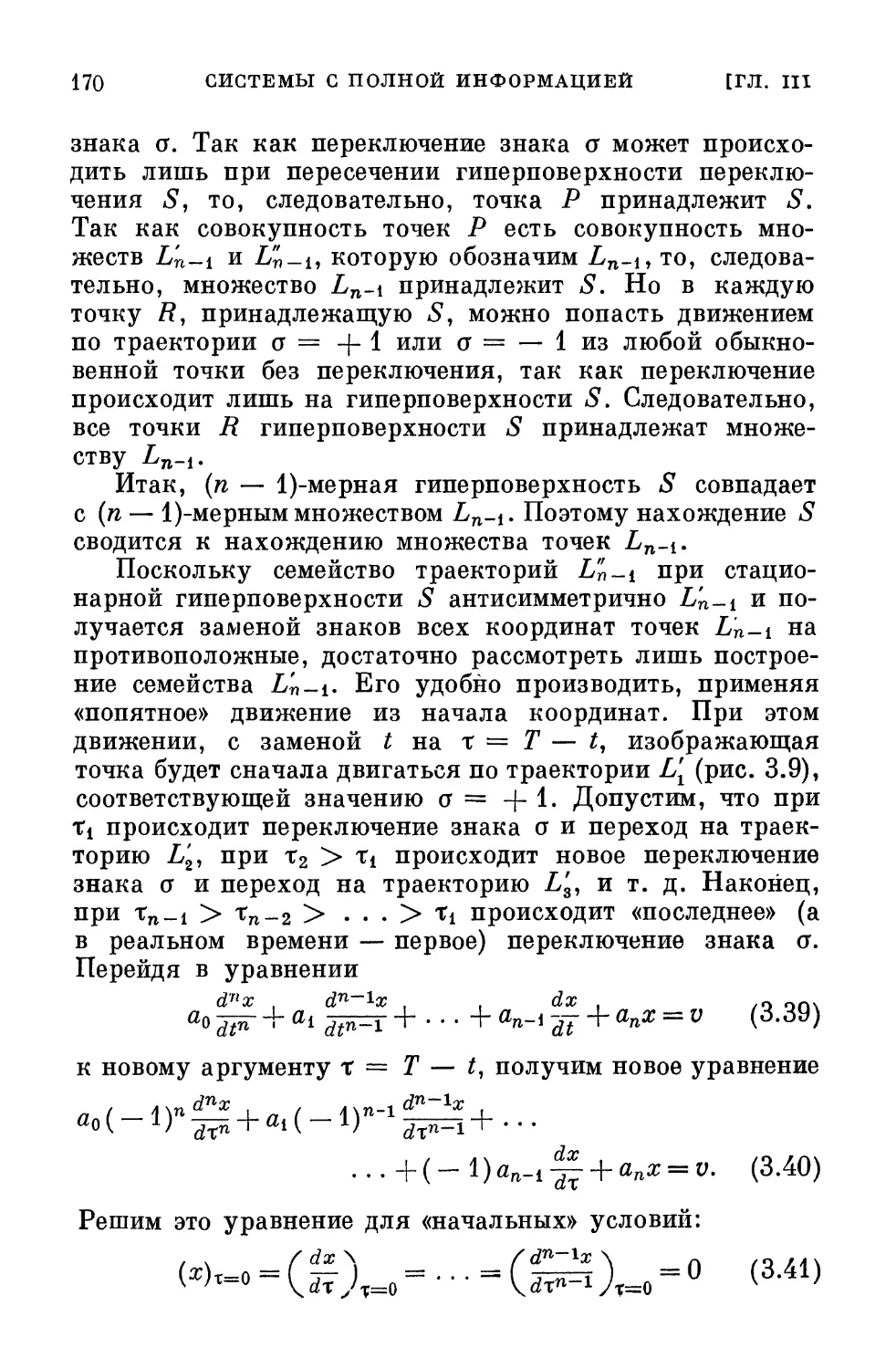

классификация сложных образов и ситуаций, замаскированных

окружающей обстановкой, шумами и т. д., позволяют

человеку достичь гибкой ориентировки в окружающей

среде и принимать правильные решения. Алгоритмы,

моделирующие сравнительно сложные функции

умственной деятельности человека, весьма сложны; поэтому

и устройство, реализующее их, также должно быть

достаточно сложной вычислительной машиной.

Параллельно с ростом техники развивается и общая

теория управления, являющаяся базой для огромного

комплекса отраслей техники, занимающихся передачей

и переработкой информации. Эту общую теорию называют

технической кибернетикой; она в свою очередь

представляет собой ветвь, направление или раздел общей

кибернетики (см. [1.1]), рассматривающей процессы

управления и переработки информации как в технических

системах, так и в живых организмах и коллективах,

составленных из живых существ и машин.

Как кибернетика вообще, так и техническая

кибернетика в частности, возникла в результате длительного

процесса обобщения ранее разрозненных теорий, идей

и принципов, развивавшихся в отдельных дисциплинах.

Этот процесс обобщения продолжается еще и сегодня.

До последних лет теория управления характеризовалась

§ ц ЗНАЧЕНИЕ ТЕОРИИ ОПТИМАЛЬНЫХ СИСТЕМ 9

радом сравнительно слабо связанных и в значительной

мере обособленных друг от друга направлений. Лишь

сейчас наметилась явственная тенденция сближения

различных направлений и кристаллизации общих понятий,

идей, методов и теории.

В настоящее время существует несколько важнейших

направлений развития технической кибернетики. Одним

из них является разработка теории и принципов

устройства сложных систем управления, состоящих из большого

количества элементов, включающих сложные

взаимосвязи частей и сложные условия работы.

Другим важным направлением в технической

кибернетике является разработка теории и принципов

действия систем с автоматическим приспособлением

(самоприспосабливающихся или адаптивных систем). Процесс

автоматического приспособления заключается в изменении

параметров, характеристик и, вообще, свойств системы

или ее частей, производимом либо в разомкнутой цепи,

либо путем автоматического регулирования, либо с

помощью автоматического поиска. Например, оптимизатор

в системе автоматической оптимизации путем

автоматического поиска так изменяет характеристики первичного

управляющего устройства, чтобы добиться его

наилучшей работы при изменении свойств управляемого

объекта. В русле этого направления находятся теории

обучающихся, самонастраивающихся и самоорганизующихся

систем.

Предметом этой книги является третье из важнейших

направлений технической кибернетики. Это направление—

теория оптимальных, т. е. наилучших, в известном смысле,

процессов и теории оптимальных систем управления,

оптимальных систем передачи и переработки информации.

Проблемы оптимальных систем становятся центральными

в силу следующих причин.

а) Любая научно обоснованная система является

оптимальной, так как, выбирая какую-либо систему, мы тем

самым предпочитаем ее другим; мы считаем,

следовательно, что она в каком-либо отношении лучше других систем.

Критерии, с помощью которых производится выбор (ниже

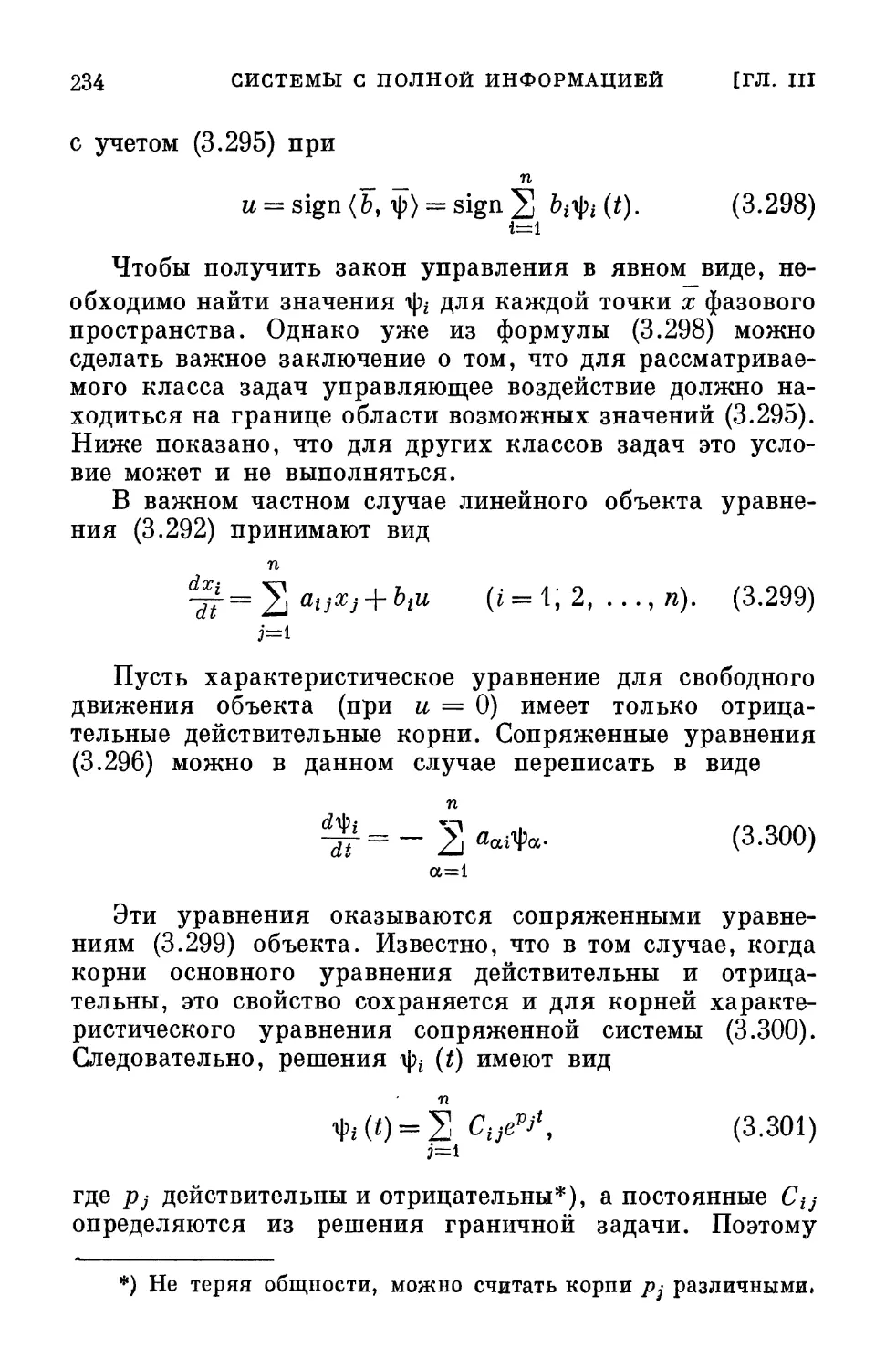

они называются критериями оптимальности), могут быть

различными. Однако при любом выборе критерий

10 ПРОБЛЕМА ОПТИМАЛЬНОЙ СИСТЕМЫ [ГЛ. I

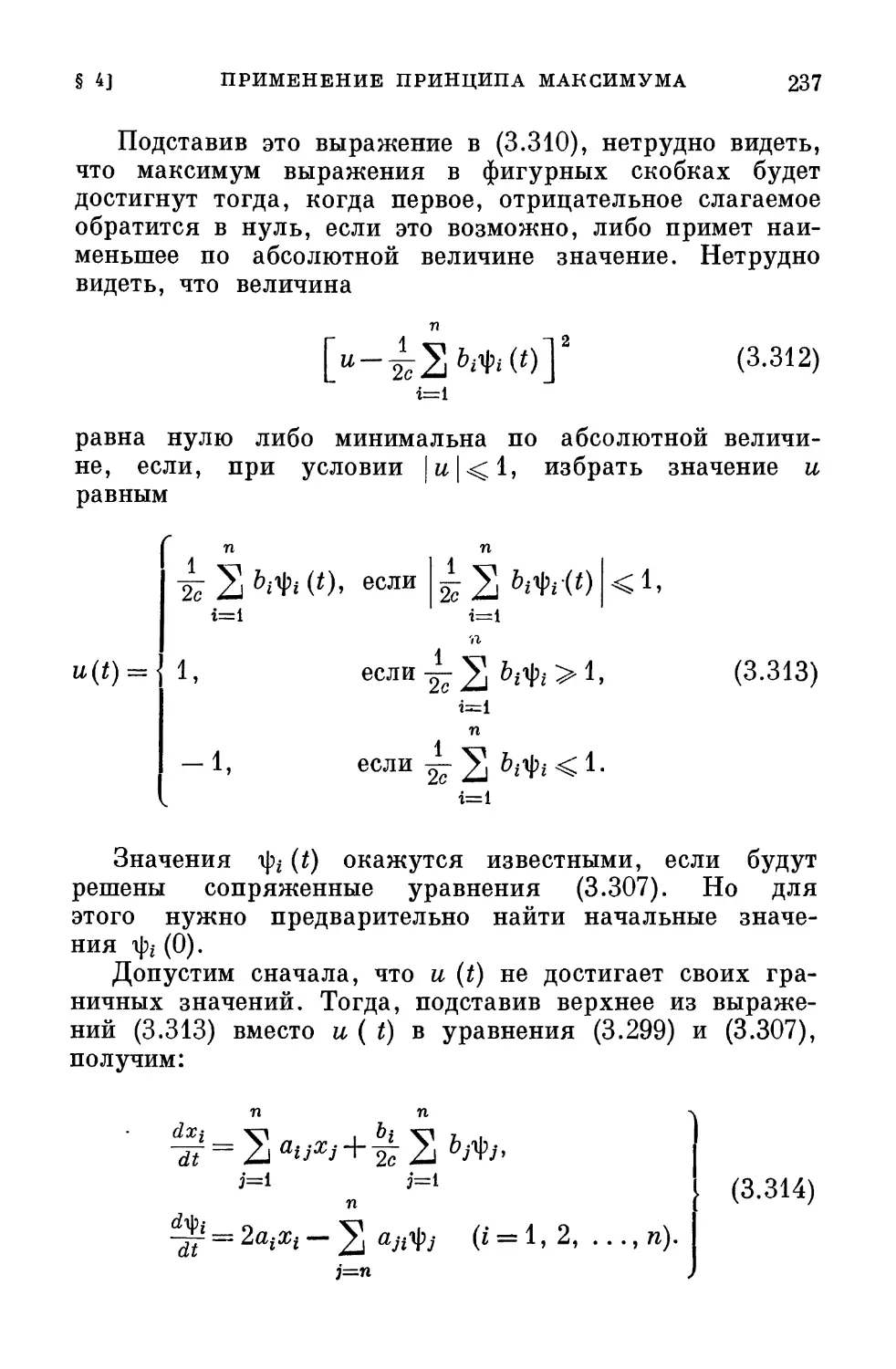

оптимальности в конечном итоге всегда существует. В

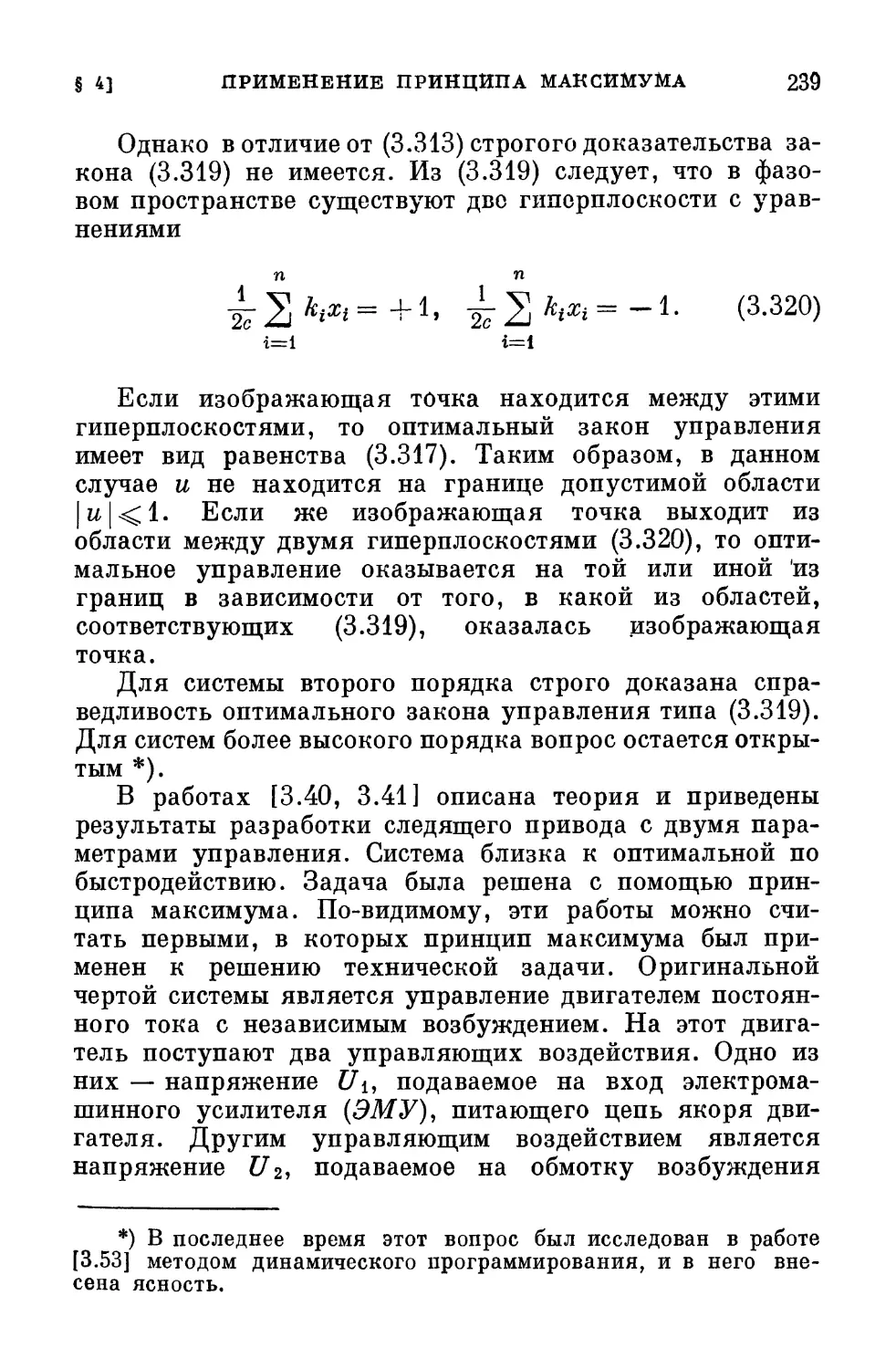

противном случае обоснованный выбор системы был бы

невозможен.

Прежде, когда производственные процессы не были

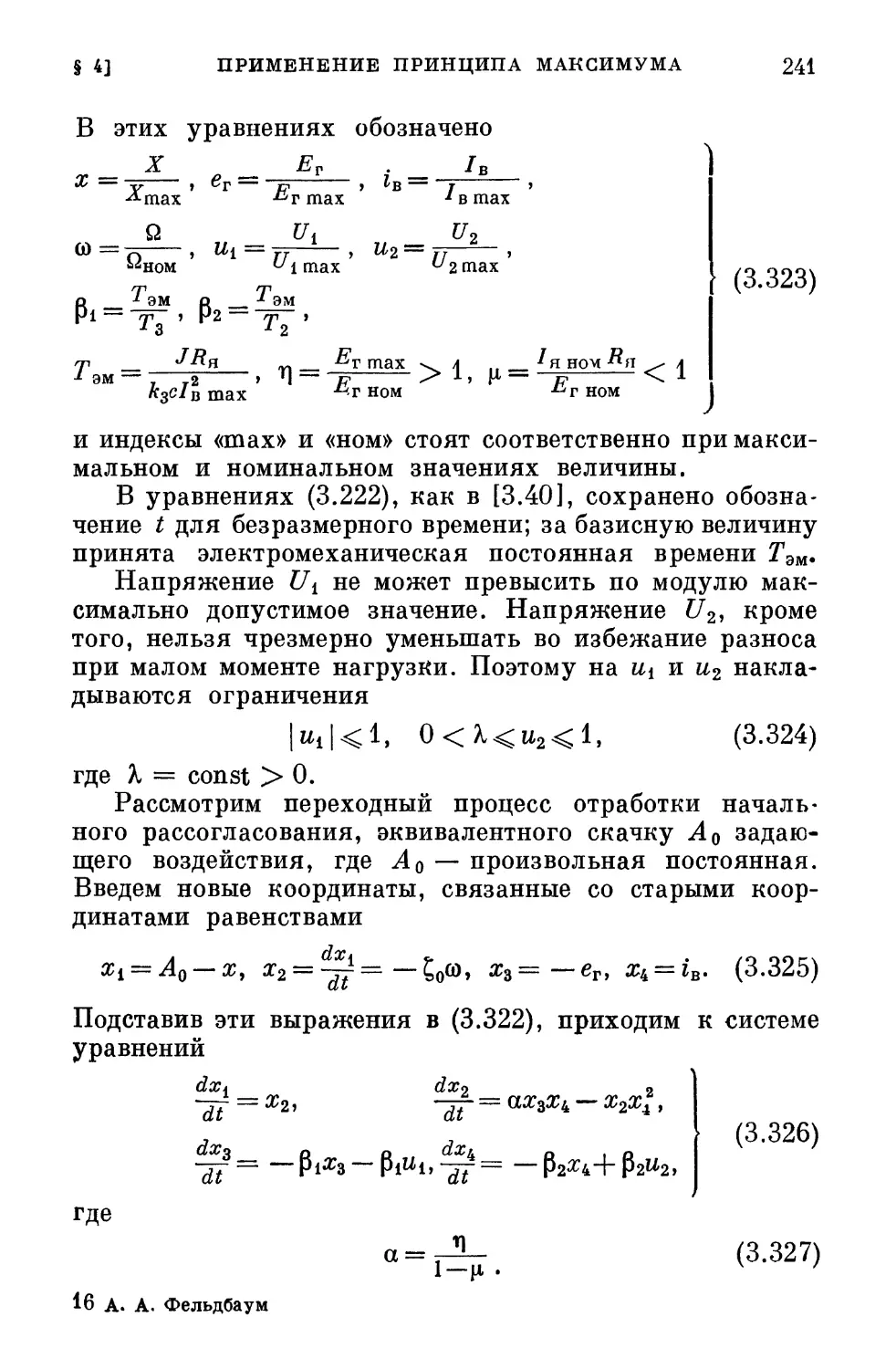

автоматизированы и технология в значительной мере

базировалась на опыте и навыках людей, когда средства

измерительной и вычислительной техники не были столь

развиты, как сейчас, попытки четкого осмысливания

и определения критериев оптимальности и, тем более,

попытки построения оптимальных систем зачастую были

беспредметными. Но сейчас мы вступаем в новую эпоху,

эпоху построения научно обоснованных и

автоматизированных производственных процессов. Поэтому возрастает

важность проблем оптимального управления. Решение

этих проблем позволит довести до максимума

эффективность использования производственных агрегатов,

увеличить производительность, улучшить качество продукции,

обеспечить экономию электроэнергии и ценного сырья

и т. д.

б) Любой закон природы есть утверждение

ограничивающего характера, утверждение о том, что можно

и чего нельзя сделать в некоторой области. Законы общего

типа в кибернетике также должны дать возможность

судить о том, что достижимо и чего нельзя достичь в

определенных реальных условиях. Поэтому они могут быть

сформулированы в виде утверждений о «потолке

возможностей» при управлении. Между тем именно

нахождение этого «потолка» есть задача теории оптимальных

систем.

Следовательно, теория оптимальных систем должна

существенно помочь в трудном деле формулировки

общих законов кибернетики. Это — дело будущего, но,

по-видимому, не столь отдаленного.

Проблемы оптимальных систем возникли во многих

областях кибернетической техники. Это — задачи

построения оптимальных по быстродействию систем

автоматического регулирования, задачи наилучшей фильтрации

сигнала от смешанного с ним шума, задачи построения

оптимальных обнаружителей сигналов, оптимальных

«предсказывающих» аппаратов, оптимальных методов

распознавания образов, оптимальной стратегии автоматиче-

§ i] ЗНАЧЕНИЕ ТЕОРИИ ОПТИМАЛЬНЫХ СИСТЕМ Ц

ского поиска и т. д. Однако между всеми этими, столь

различными на первый взгляд, задачами имеется

глубокая внутренняя связь. В последующем изложении эта

связь будет выявляться и подчеркиваться. Именно эта

связь является базой для построения единой теории

оптимальных систем.

В технической кибернетике имеются, кроме

перечисленных выше, и иные важные направления — например,

изучение устойчивости и автоколебаний систем. Кроме

того, такие важнейшие направления, как общая теория

систем (частью которой является теория автоматов) и общая

теория сигналов (частью которой является теория

информации), принадлежат общей кибернетике не в меньшей

мере, чем технической.

Указанные направления вовсе не независимы друг

от друга. Напротив, между ними имеется определенная

связь. Например, в теории конечных автоматов

представляет большой интерес определение наиболее простой

структуры автомата, реализующей заданный алгоритм.

Такая система будет оптимальной по простоте. Ставятся

также задачи нахождения наиболее надежных, при

заданной сложности, автоматов. Это — системы,

оптимальные по надежности. Еще более тесно связаны с

теорией оптимальных систем вопросы автоматического

приспособления. Наиболее важную область этих вопросов

составляет теория систем автоматической оптимизации,

связанная с теорией оптимальных систем по многим

каналам. Перечислим некоторые из них.

а) Оптимальная система — это тот идеал, к которому

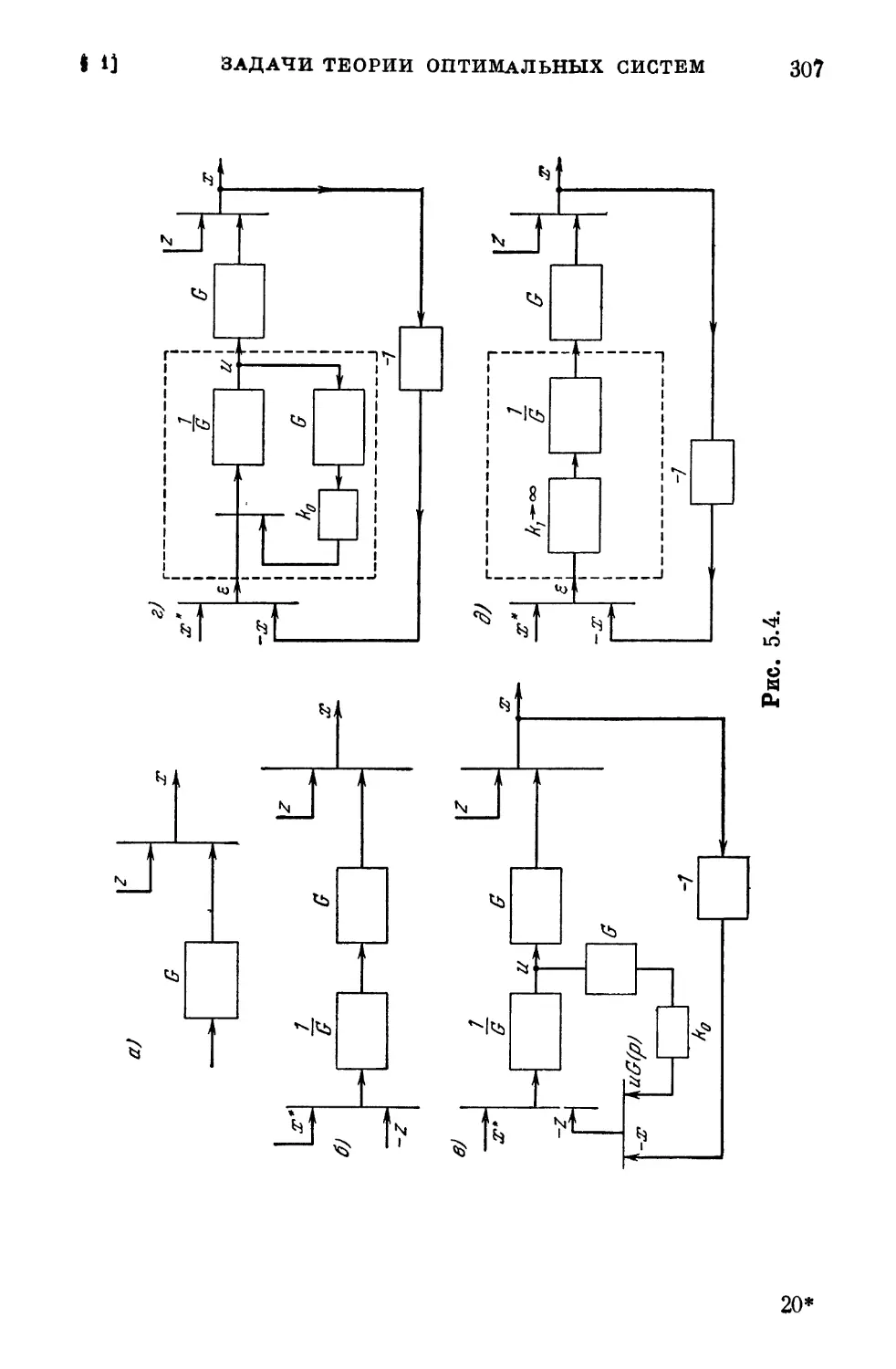

стремится (но которого не всегда достигает) система

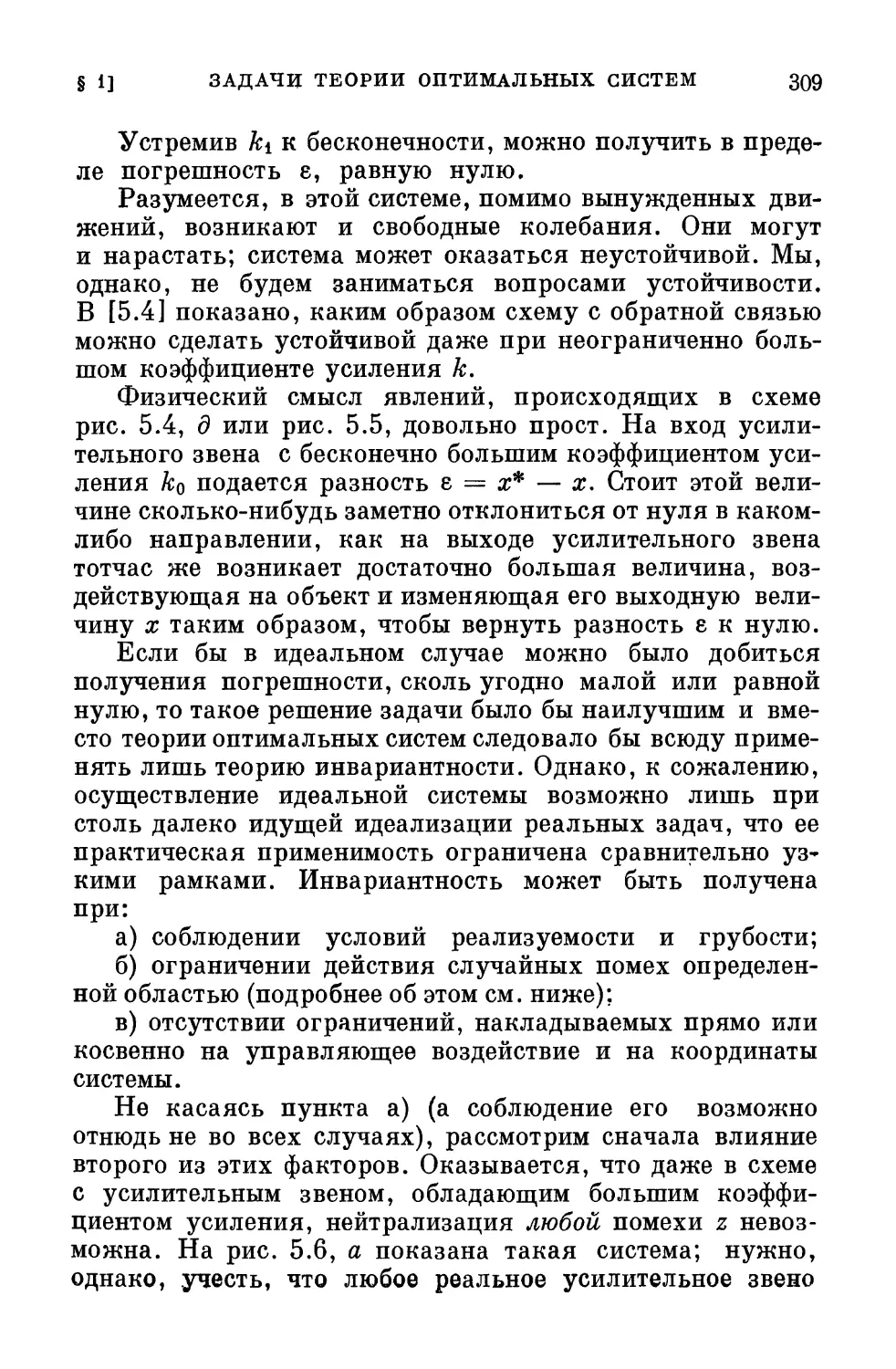

автоматической оптимизации.

б) При достаточно медленном изменении характеристик

управляемого объекта можно строить первичное

управляющее устройство согласно теории оптимальных систем,

снабдив его, однако, изменяемыми параметрами.

Вторичное управляющее устройство — автоматический

оптимизатор,— наблюдая работу системы, изменяет

параметры первичного устройства так, чтобы система в

целом оставалась близкой к оптимальной, несмотря на

непредвиденное изменение характеристик управляемого

объекта.

12

ПРОБЛЕМА ОПТИМАЛЬНОЙ СИСТЕМЫ

[ГЛ. I

в) Когда характеристики объекта изменяются

сравнительно быстро, то система, работающая согласно

указанному выше принципу, может оказаться далекой от

оптимальной. В этом случае возникает задача отыскания

наилучшего алгоритма поиска оптимальных методов

управления, задача создания оптимальной системы

автоматического поиска либо,

вообще, оптимальной

системы

автоматического приспособления.

Теория

оптимальных систем тесно

связана с другими

направлениями

технической кибернетики

хотя бы уже потому,

что любую задачу,

выполняемую

управляющим устройством,

можно решить наилучшим,

оптимальным в каком-

либо смысле способом.

Следовательно, в

любой области технической кибернетики возникают задачи

построения оптимальных систем.

Коснемся вкратце, например, задачи построения

оптимальных по быстродействию систем автоматического

регулирования. Эта задача возникает при разработке

следящих систем, автоматических компенсаторов, подъемных

устройств, следящих приводов технологических

агрегатов, при проектировании и эксплуатации химических

и металлургических реакторов и печей, в системах

управления ракетами, а также в ряде иных областей.

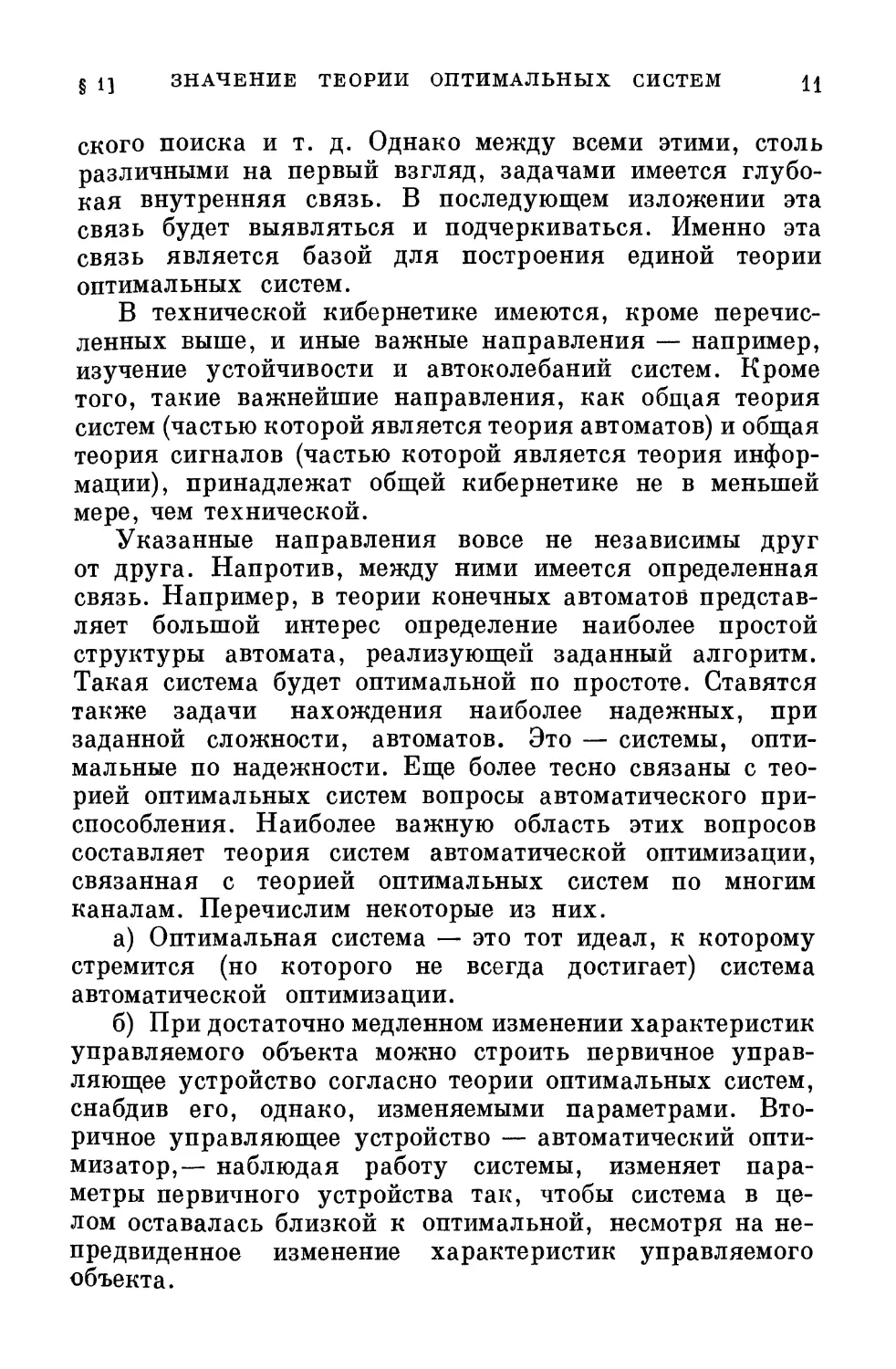

Рассмотрим в качестве примера автоматический компенсатор

(рис. 1.1). Задача этого устройства состоит в измерении

и регистрации напряжения Е, которое может изменяться

со временем. В компенсаторе измеряется разность Д?/

между напряжением Е и компенсирующим его

напряжением U. Последнее представляет собой разность

потенциалов между движком Д потенциометра П и нижней

точкой потенциометра. На потенциометр подается стяг

Рис. 1.1.

§ 1] ЗНАЧЕНИЕ ТЕОРИИ ОПТИМАЛЬНЫХ СИСТЕМ 13

бильное постоянное напряжение С/о, заведомо большее,

чем Е. Предполагается, что потенциометр имеет

равномерную намотку. Допустим сначала, что положение

движка Д всегда таково, что имеет место компенсация,

т #е. Е = U. Тогда разность АС/ = 0. В этом положении

координата движка Д пропорциональна измеряемому

напряжению Е. Поэтому перо, прикрепленное к движку Д,

может чертить на равномерно перемещающейся бумаж-^

ной ленте (не показанной на рисунке) график изменения Е

в функции времени.

Итак, задача автоматического потенциометра

заключается в том, чтобы поддерживать с достаточной

точностью равенство АС/ = 0. Напряжение АС/ подается на вход

устройства У, где оно усиливается и преобразуется.

Выходное напряжение U\ устройства У поступает на

сервомотор С. Если АС/ отклоняется от нуля, то на входе

сервомотора С появляется напряжение C/i и вал

сервомотора начинает вращаться, изменяя через посредство

редуктора Р положение движка Д так, чтобы

восстановилось равенство Е = С/.

Если система достаточно точна и напряжение Е

меняется достаточно медленно, то условие АС/ = 0

поддерживается с требуемой точностью. Однако в том случае, когда

напряжение Е может изменяться с большой быстротой,

требуется, чтобы автоматический компенсатор был

быстродействующим. Наиболее тяжелый случай соответствует

скачку напряжения Е — например, от значения, равного

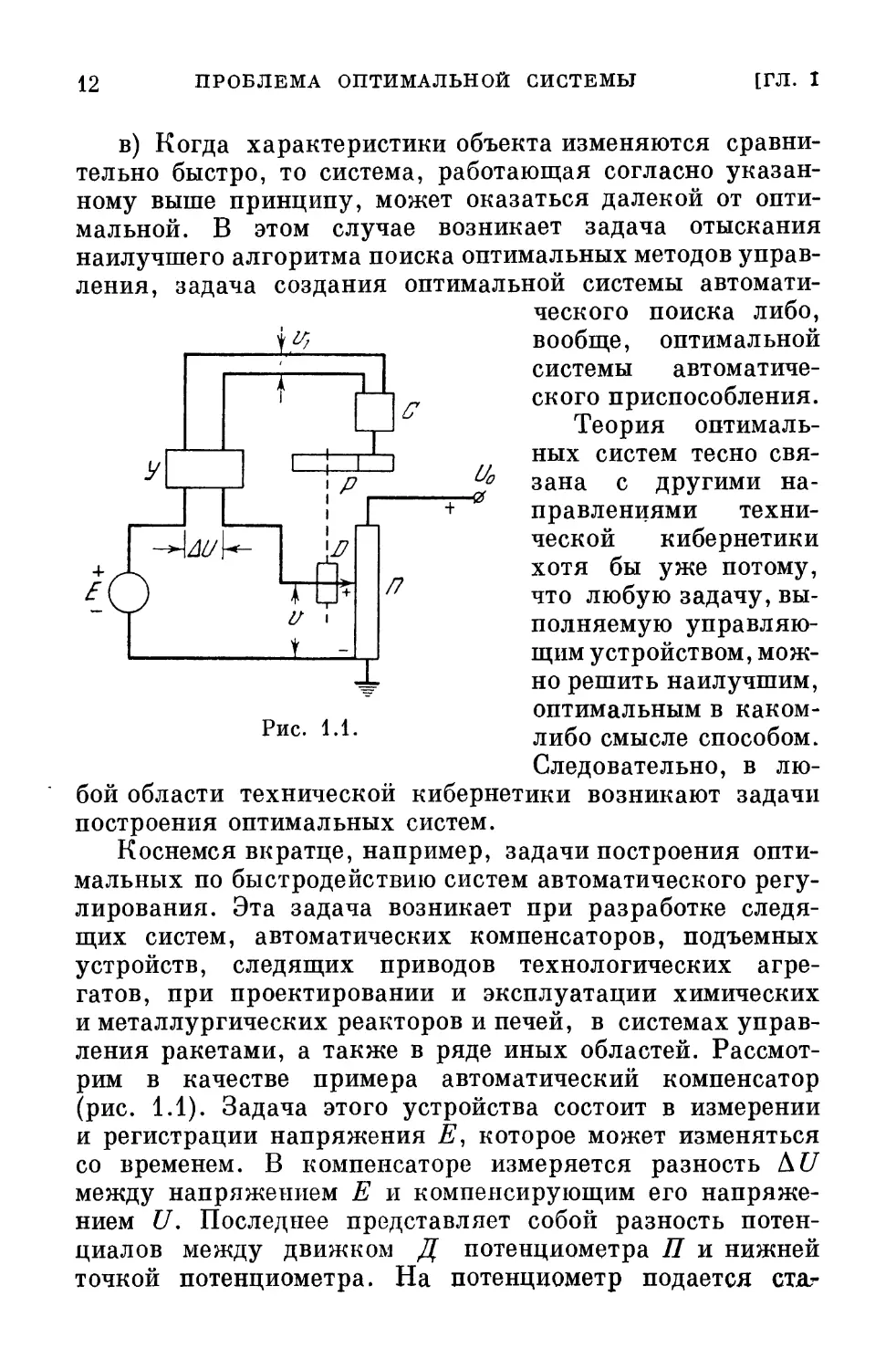

нулю, до i?max (рис. 1.2, где предполагается, что скачок

происходит при t = 0).

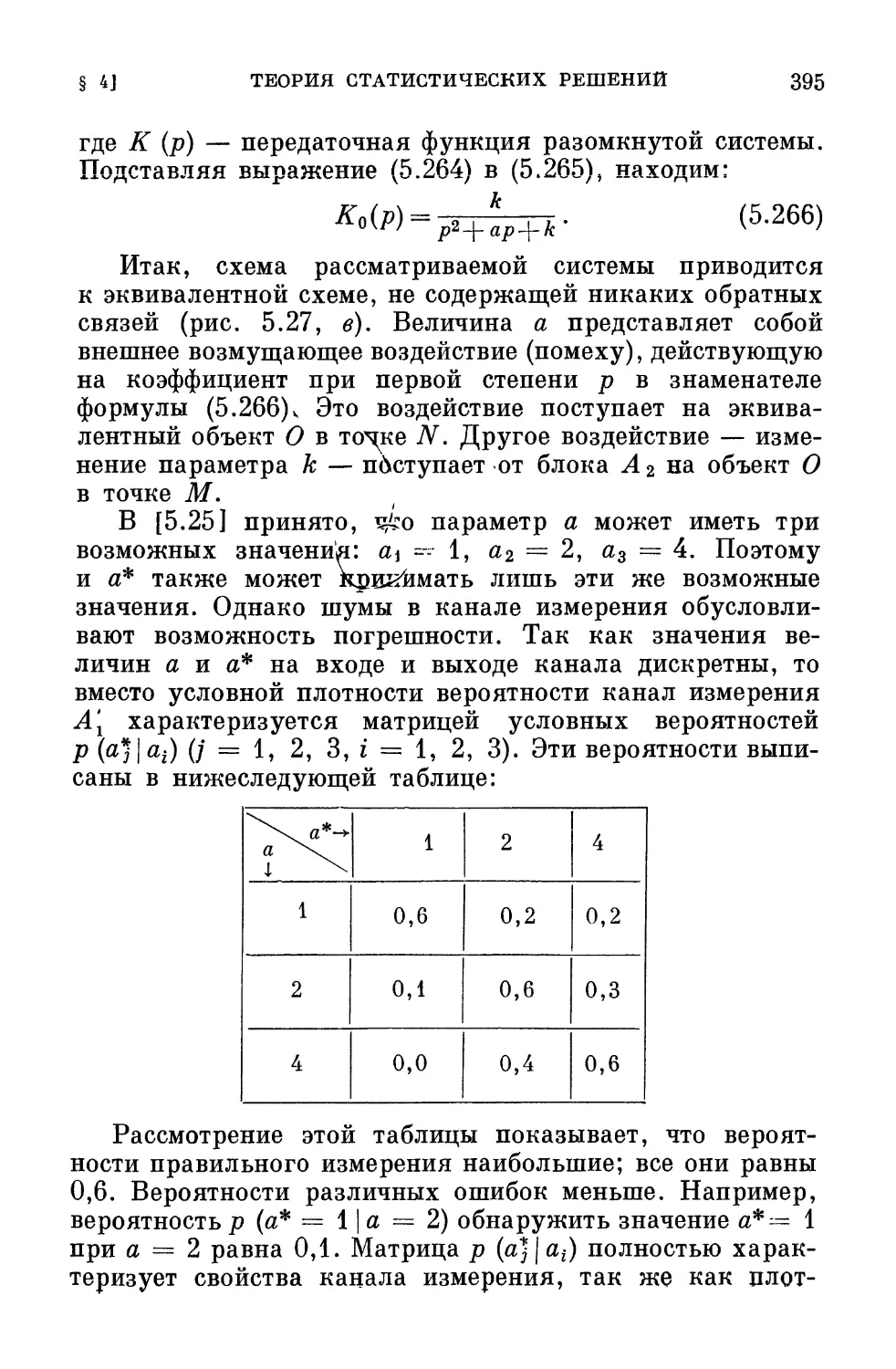

В идеальной системе и напряжение С/ должно было бы

при t — 0 скачком измениться от 0 до Етах. Однако

очевидно, что в реальном компенсаторе такой скачок

невозможен. Действительно, сервомотор С не может

развивать момент (а следовательно, и ускорение), больший

некоторого максимально возможного. Обычно существует

и ограничение, наложенное на скорость вращения вала

сервомотора. Последняя также не может превосходить

максимально возможную. Поэтому можно лишь

потребовать, чтобы кривая U = U (t) (рис. 1.2) по возможности

быстрее, т. е. при минимальном значении t = Т, достигла

бы области Smax— АЕ < U < Етах+ Д?\ где Д2? —

14

ПРОБЛЕМА ОПТИМАЛЬНОЙ СИСТЕМЫ

[ГЛ. I

достаточно малая величина, причем U будет находиться

в этой области и при t > Т. Величина Т называется

временем регулирования. Требуется так сконструировать

управляющее устройство У (либо только его входную,

маломощную часть, если мощные каскады усилителя

заданы), чтобы обеспечить условие Т = min при

заданных ограничениях, наложенных на параметры

сервомотора С. Такая система будет наиболее^ быстродействующей

или, иначе, оптимальной по быстродействию.

Рис. 1.2.

Задача построения системы, оптимальной по

быстродействию, весьма сложна даже в простейших случаях.

Действительно, допустим сначала, что движение всей

системы в целом описывается линейным

дифференциальным уравнением второго порядка с постоянными

коэффициентами. При малых коэффициентах демпфирования (т. е.

малых коэффициентах при первой производной U в

уравнении) кривая U (t) имеет резко колебательный характер

(кривая 1 на рис. 1.2). В этом случае время

регулирования Т = Т\ велико. Если сделать коэффициент

демпфирования большим, то процесс U = U (t) приобретает

апериодический характер (кривая 2 на рис. 1.2). В этом случае

время регулирования Т = Т2 также велико. Путем

оптимальной установки коэффициента демпфирования (он

обычно выбирается чуть меньшим критического) можно

уменьшить время регулирования. Соответствующая кри-

§ tj ЗНАЧЕНИЕ ТЕОРИИ ОПТИМАЛЬНЫХ СИСТЕМ 15

вая не показана на рисунке. Однако простейшие

соображения показывают, что можно достичь лучших

результатов, перейдя к нелинейной системе.

Сделаем коэффициент демпфирования зависящим от

разности АС/ между Е и С/'. Пусть при больших значениях АС/

он будет мал, икривая U (t), обозначенная Зна рис. 1.2,

пойдет по кривой 1. Пусть, однако, когда разность АС/

станет малой, коэффициент демпфирования резко

увеличится. Тогда «хвост» кривой 3 получит такой же

характер, как и у кривой 2; кривая 3 плавно подойдет к

значению Етах, и время регулирования Т = Т3 окажется

значительно меньшим, чем у любой линейной системы.

Эти простейшие соображения оправдываются теорией

и экспериментом. Оказывается, что система, оптимальная

по быстродействию, даже в рассматриваемом простейшем

случае должна быть нелинейной. Между тем

исследование нелинейных систем, вообще говоря, несравненно

более трудно, чем изучение линейных. Но практическое

и общетеоретическое значение теории оптимальных систем

настолько велико, что вполне оправдывает большой труд,

затрачиваемый на ее развитие.

Общетеоретическая значимость теории оптимальных

систем была подчеркнута выше. Что касается

практического значения этой теории, то здесь следует различать

два аспекта. Во-первых, без нее невозможно

конструировать оптимальные или близкие к ним автоматические

системы. Действительно, зачастую даже в простых

случаях интуиция инженера совершенно недостаточна для

нахождения оптимальных законов действия управляющих

устройств. Между тем оптимальные режимы работы

агрегатов могут обеспечить очень большой экономический

эффект; в оборонной технике пригодны критерии

совершенно иного типа, но и там значение оптимальных систем

очевидно. С другой стороны, теория оптимальных систем

позволяет оценить «потолок», который может быть

достигнут в наилучшей, оптимальной системе, и сравнить его

с показателями действующей, неоптимальной системы.

Это сравнение позволяет выяснить, следует ли в

рассматриваемом случае заниматься разработкой

оптимальной системы или можно удовлетвориться

существующей.

16 ПРОБЛЕМА ОПТИМАЛЬНОЙ СИСТЕМЫ

§ 2. Классификация оптимальных систем

[ГЛ. I

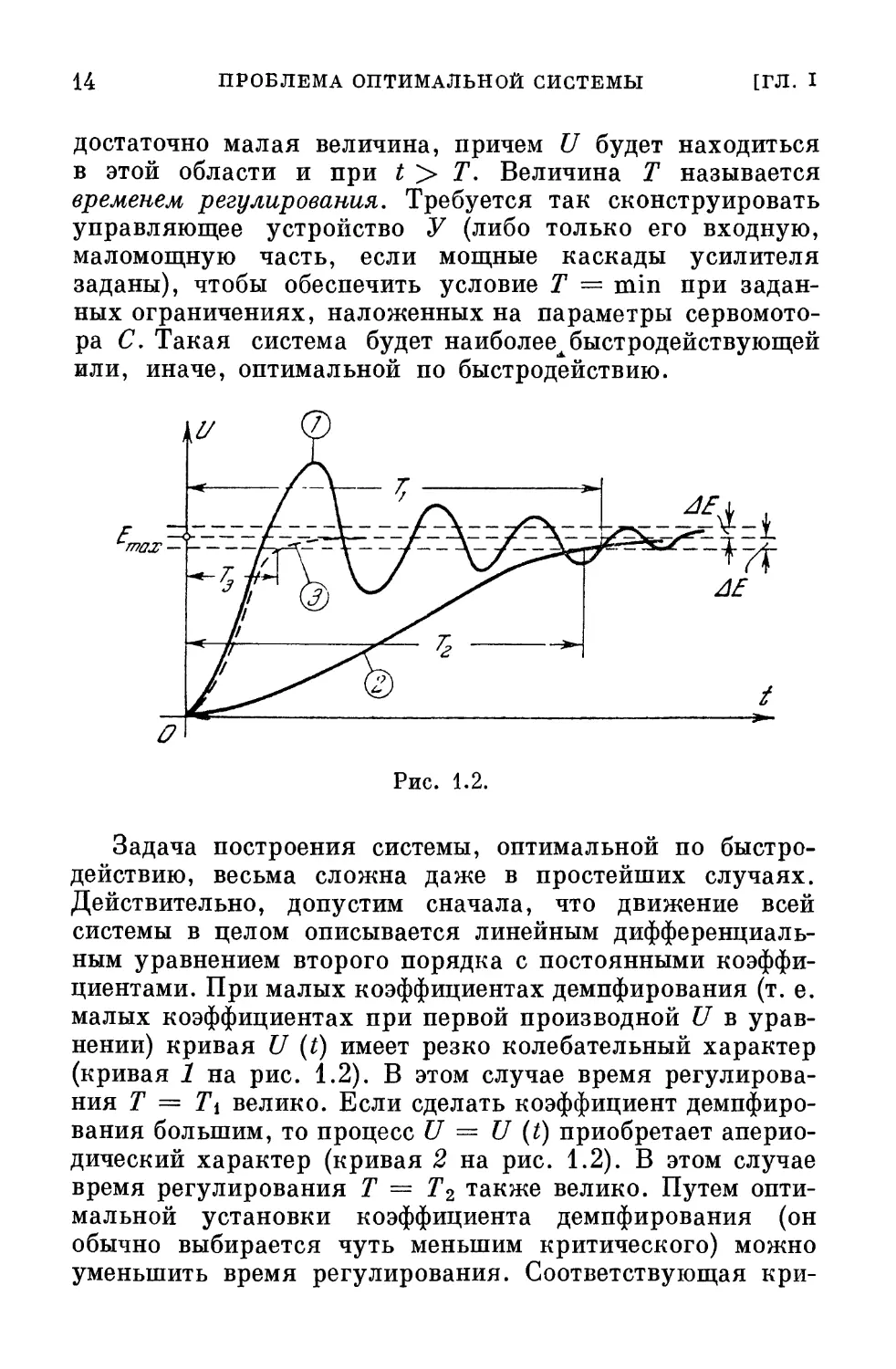

На рис. 1.3 изображена структурная схема системы

автоматического управления. Буквой А обозначено

управляющее устройство, а буквой В — управляемый объект.

Природа объекта может быть любой. В качестве

управляемого объекта может фигурировать, например, прокатный

стан либо химический реактор. Управляемым объектом

может быть цех предприятия или отдельный двигатель.

X'

*

1

1

\

В

Рис. 1.3.

На выходе объекта В появляется управляемая величина х.

Под управляемой величиной понимаются параметры,

характеризующие состояние управляемого объекта. В общем

случае имеется несколько таких параметров xi, . . . , хп.

Удобно считать эти величины координатами вектора х:

х*={х2, ..., хп). A.1)

Вектор х называется также выходным вектором или

выходной величиной объекта В.

На вход объекта В поступает управляющее

воздействие и от управляющего устройства А. Если таких

воздействий несколько — ui, и2, . . . , иг, то их можно

объединить в вектор п с координатами Uj (/ = 1, . . . , г):

= (щ, ..., иг).

A.2)

На вход управляющего устройства А подается

задающее воздействие #*, представляющее собой инструкцию

о том, какой должна быть выходная величина х объекта.

Эта инструкция должна конкретизировать цель

управления (соответствующее понятие уточняется в следующем

параграфе). Инструкция может представлять собой кол-

§ 2] КЛАССИФИКАЦИЯ ОПТИМАЛЬНЫХ СИСТЕМ 17

лекцию из п величин ж*, . . . , х*, которые будем

считать координатами вектора х*:

** = (*!, ...,*?). A.3)

Например, можно потребовать, чтобы в идеальном

случае удовлетворялись условия

хх = х\ (i = l, ..., п), A.4)

ще х\— заданные функции времени.

Системы автоматического управления разделяются на

два класса: разомкнутые и замкнутые системы. Последний

класс называется также системами с обратной связью.

В разомкнутых системах управляющее устройство не

получает информации о действительном состоянии х объекта В.

В замкнутых системах управляющее устройство А

получает эту информацию по линии обратной связи (внизу

на рис. 1.3). Принцип действия замкнутой системы может

быть вкратце охарактеризован следующим образом: если

величина х не соответствует требованиям #*, то

управляющее устройство А оказывает такое воздействие п на

объект J5, чтобы приблизить х к этим требованиям.

Отклонение величины х от требований может

произойти от различных причин.

а) Неправильное, неточное или запоздалое

использование устройством А содержащейся в нем или приходящей

к нему информации о характеристиках и состоянии

объекта и о цели управления. Этот недостаток, в принципе,

может быть исправлен усовершенствованием закона

действия (алгоритма) управляющего устройства А.

б) Ограничение ресурсов управления, т. е.

невозможность, по тем или иным причинам, подавать на объект В

такие управляющие воздействия й, которые обеспечили бы

требуемое поведение х объекта. На практике ресурсы

управления всегда ограничены, и это обстоятельство

необходимо учитывать.

в) Причиной отклонения х от требований может

оказаться некоторое заранее непредвиденное и не

контролируемое возмущающее воздействие z, поступающее на объект

В и влияющее на его выходную величину х. Если на раз-

18 ПРОБЛЕМА ОПТИМАЛЬНОЙ СИСТЕМЫ [ГЛ. I

личные части объекта В действуют возмущения Zi, . . ., zL,

то мы будем представлять их в виде вектора z:

z = (zu ...,zt). A.5)

Возмущающее воздействие z часто называют помехой.

Помехи, действующие на управляемый объект В, могут

вызывать заранее не предвиденное изменение его

характеристик. Влияние изменения нагрузки на объект можно

рассматривать как частный случай действия помехи.

Допустим, что алгоритм управляющего устройства А

обеспечивает успешную работу системы при

определенных характеристиках объекта В. Однако при их

изменении работа системы может ухудшиться и величина х

станет значительно отклоняться от требований.

Принцип обратной связи во многих случаях создает

возможность удовлетворения требованиям,

предъявляемым к величине х, даже при наличии значительной помехи

z, действующей на объект В. Однако если характеристики

объекта В сложны и быстро изменяются в широком

диапазоне, то задача управления затрудняется. В таких

случаях получение информации о помехе z или хотя бы о

некоторых ее составляющих z\, . . ., zi* (/'< /) может оказать

существенную помощь и улучшает результат управления.

Пусть помеха измеряется и результат измерения

поступает (см. пунктирную линию на рис. 1.3) в управляющее

устройство А. Тогда последнее может рассчитать и подать

такое управляющее воздействие й, которое скомпенсирует,

нейтрализует влияние помехи z и приведет выходную

величину х объекта В в лучшее соответствие с

требованиями. Этот прием носит название компенсации. Цепь

компенсации на рис. 1.1 не является линией обратной

связи, т. к. по ней передается значение входной, а не

выходной величины объекта. Системы, в которых наряду

с принципом обратной связи применяется принцип

компенсации, иногда называются комбинированными.

Следует отметить, что область применения принципа

компенсации гораздо уже области применения принципа

обратной связи. Это объясняется главным образом тем, что

на объект В действует большое количество различных

§ 2]

КЛАССИФИКАЦИЯ ОПТИМАЛЬНЫХ СИСТЕМ 19

помех 2i, . . ., zi. Значительная часть этих помех вообще

не поддается измерению, а потому и не может быть

скомпенсирована с помощью цепи, показанной пунктиром

на рис. 1.3. Даже если бы и существовала принципиальная

возможность измерения множества помех ziy то расчет

нейтрализующего их воздействия а был бы чрезмерно

сложным. Поэтому управляющее устройство А оказалось бы

слишком громоздким, а результаты работы системы могли

бы все же быть недостаточно успешными, так как не все

помехи можно измерить. Между тем принцип обратной

связи позволяет измерять только лишь отклонение

управляемой величины х от требований и формировать

управляющее воздействие и, которое приближает х к

требуемому значению. Очевидно, что принцип обратной связи

гораздо более универсален и, вообще говоря, приводит

к более простым методам управления, чем принцип

компенсации. Однако в ряде случаев, когда измерение

основного возмущающего воздействия осуществляется

достаточно просто, метод компенсации или его сочетание с

принципом обратной связи оказывается наиболее удачным.

Обычно объект В задан и его свойства изменять нельзя.

Между тем алгоритм управляющего устройства А большей

частью вовсе не задан, и его можно выбирать из широкого

класса возможных алгоритмов*). Задача построения

оптимальной системы сводится, таким образом, к задаче

разработки такого управляющего устройства А, которое, в

известном смысле, наилучшим образом управляет объектом В.

На практике к устройству А обычно предъявляется

ряд самостоятельных требований, не имеющих прямого

отношения к объекту В. Например, можно потребовать,

чтобы устройство А было достаточно надежным, а также

не слишком сложным. Можно потребовать, чтобы его

вес, габариты или потребление энергии были не слишком

большими. Можно для облегчения расчетов либо по иным

соображениям принять устройство А линейным или даже

заранее задать его структурную схему, считая

неизвестными в ней только параметры отдельных звеньев. Однако

*) Нередко мощная силовая часть управляющего устройства

задана; тогда ее следует, относить к управляемому объекту

и считать его частью. Поэтому иногда «управляемый объект»

заменяют понятием «неизменяемая часть системы».

20 ПРОБЛЕМА ОПТИМАЛЬНОЙ СИСТЕМЫ [ГЛ. I

ниже основное внимание обращено на такое рассмотрение,

в котором отсутствуют какие-либо требования или

ограничения, касающиеся непосредственно управляющего

устройства А. Допустим, что, если потребуется, это

устройство может быть любым — например, сколь угодно

сложным, а также безынерционным. Такое отсутствие

ограничений обусловлено обширными возможностями

современной вычислительной техники (см. предыдущий параграф).

Кроме того, наложение дополнительных ограничений

на управляющее устройство А может, вообще говоря,

резко усложнить задачу нахождения оптимальной

системы. Такое усложнение возникает, если, например,

потребовать, чтобы сложность или надежность, либо

стоимость управляющего устройства А не переходили

через некоторую верхнюю грань. Разумеется, если

ограничить выбор устройства А известным, заранее

определенным классом систем, либо заранее выбрать схему и

считать неизвестными лишь ее параметры, то задача сильно

упрощается. Однако ценность ее решения, как правило,

падает в еще большей мере. Действительно, самое трудное

при создании оптимального управляющего устройства —

это определение общего вида, общей структуры алгоритма.

К сожалению, интуиция инженера или математика может

оказать здесь помощь лишь в самых простейших случаях

и бессильна в сколько-нибудь более сложных. Поэтому

заранее, как правило, не известны ни общий вид

алгоритма, ни даже достаточно узкий класс зависимостей,

к которому он принадлежит. Всякий необоснованный

априорный выбор узкого класса зависимостей лишает

поэтому решение задачи той ценности, какую оно имело бы

при отсутствии подобных ограничений.

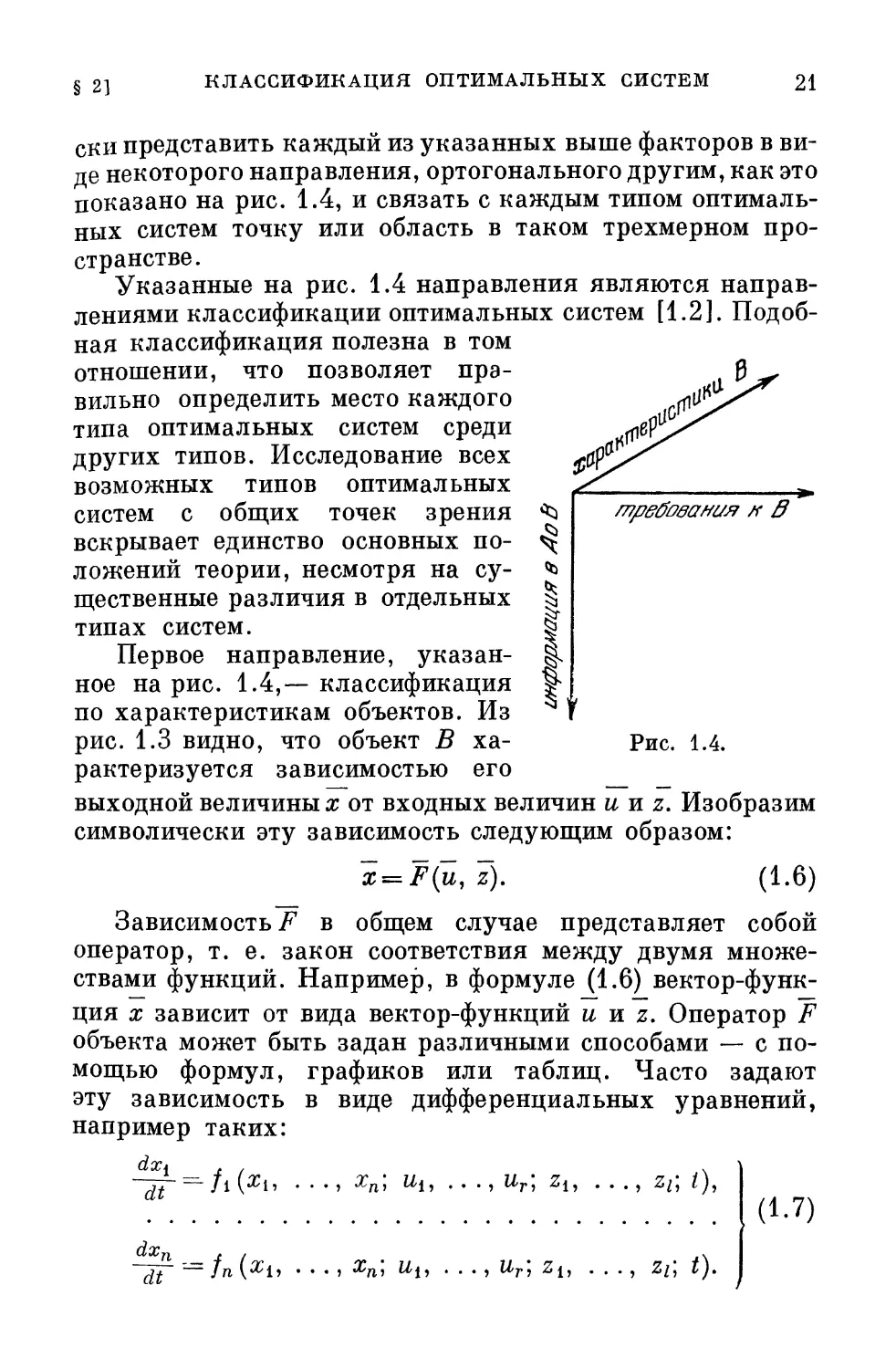

Если ограничения, наложенные на А, отсутствуют, то

алгоритм оптимального устройства А определяется лишь

следующими факторами, относящимися к объекту В

и способу его соединения с А:

1) характеристики объекта В;

2) требования, предъявляемые к объекту В;

3) характер информации об объекте 5, поступающей

в управляющее устройство А.

Подробное рассмотрение этих факторов необходимо

в целях детальной постановки задачи. Можно символиче-

§ 2]

КЛАССИФИКАЦИЯ ОПТИМАЛЬНЫХ СИСТЕМ

21

требования /г д

ски представить каждый из указанных выше факторов в

виде некоторого направления, ортогонального другим, как это

показано на рис. 1.4, и связать с каждым типом

оптимальных систем точку или область в таком трехмерном

пространстве.

Указанные на рис. 1.4 направления являются

направлениями классификации оптимальных систем [1.2].

Подобная классификация полезна в том

отношении, что позволяет

правильно определить место каждого

типа оптимальных систем среди

других типов. Исследование всех

возможных типов оптимальных

систем с общих точек зрения с

вскрывает единство основных по- *

ложений теории, несмотря на су- (

щественные различия в отдельных |

типах систем. !

Первое направление, указан- !

ное на рис. 1.4,— классификация ]

по характеристикам объектов. Из

рис. 1.3 видно, что объект В

характеризуется зависимостью его

выходной величины х от входных величин и и z. Изобразим

символически эту зависимость следующим образом:

x = F(Z, I). A.6)

Зависимость/1 в общем случае представляет собой

оператор, т. е. закон соответствия между двумя

множествами функций. Например, в формуле A.6)

вектор-функция х зависит от вида вектор-функций и и z. Оператор F

объекта может быть задан различными способами — с

помощью формул, графиков или таблиц. Часто задают

эту зависимость в виде дифференциальных уравнений,

например таких:

Рис. 1.4.

dt

dxn

, , Хп, III, . . . , Ur,

A.7)

ur; zlt . .., zu t).

22

ПРОБЛЕМА ОПТИМАЛЬНОЙ СИСТЕМЫ

[ГЛ. I

Здесь fi— в общем случае нелинейные функции от

#i, . . . , хп\ их, . . . , ит\ zt, . . . , zi и времени t. Введя

векторные обозначения

dx / dx\ dx-n \ ~т /t г \ //|Q\

— i, ? ..., ) » / == {Tli •••» /п/» \^#"/

можно переписать уравнения A.7) в более компактной

и легко обозримой векторной форме:

u>

0.

A.9)

Вектор / в этом выражении представляет собой вектор-

функцию векторов х, и, z и скаляра t. Уравнения A.7)

или A.9) при заданных начальных условиях, т. е. при

заданном векторе хт = (х™\ . . . , хТ ), где

xT = (xt)t=o (i=l, ..., л), A.10)

позволяют найти вектор x(t), если_ только известна

вектор-функция u(t) и задана помеха z(t).

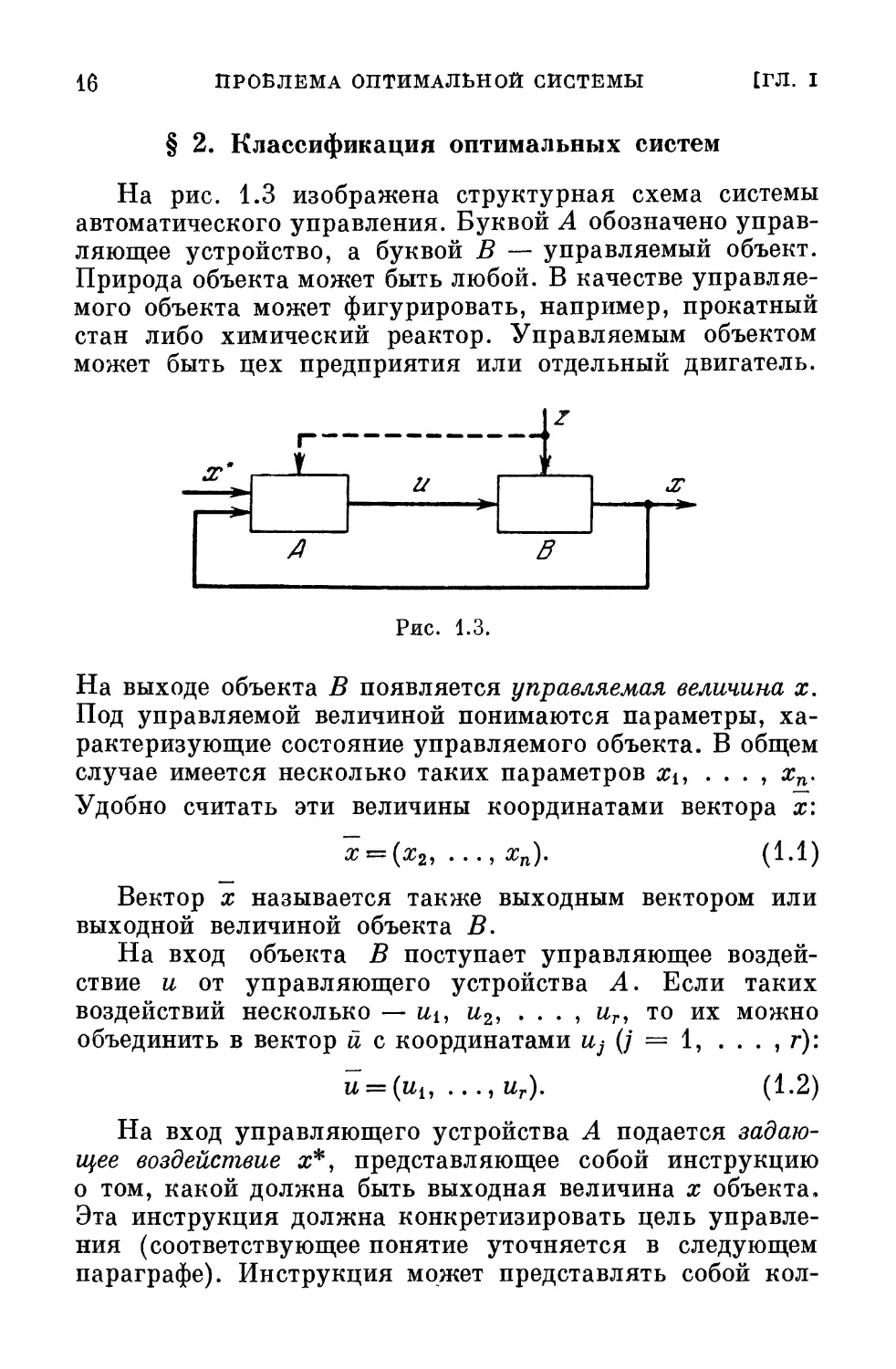

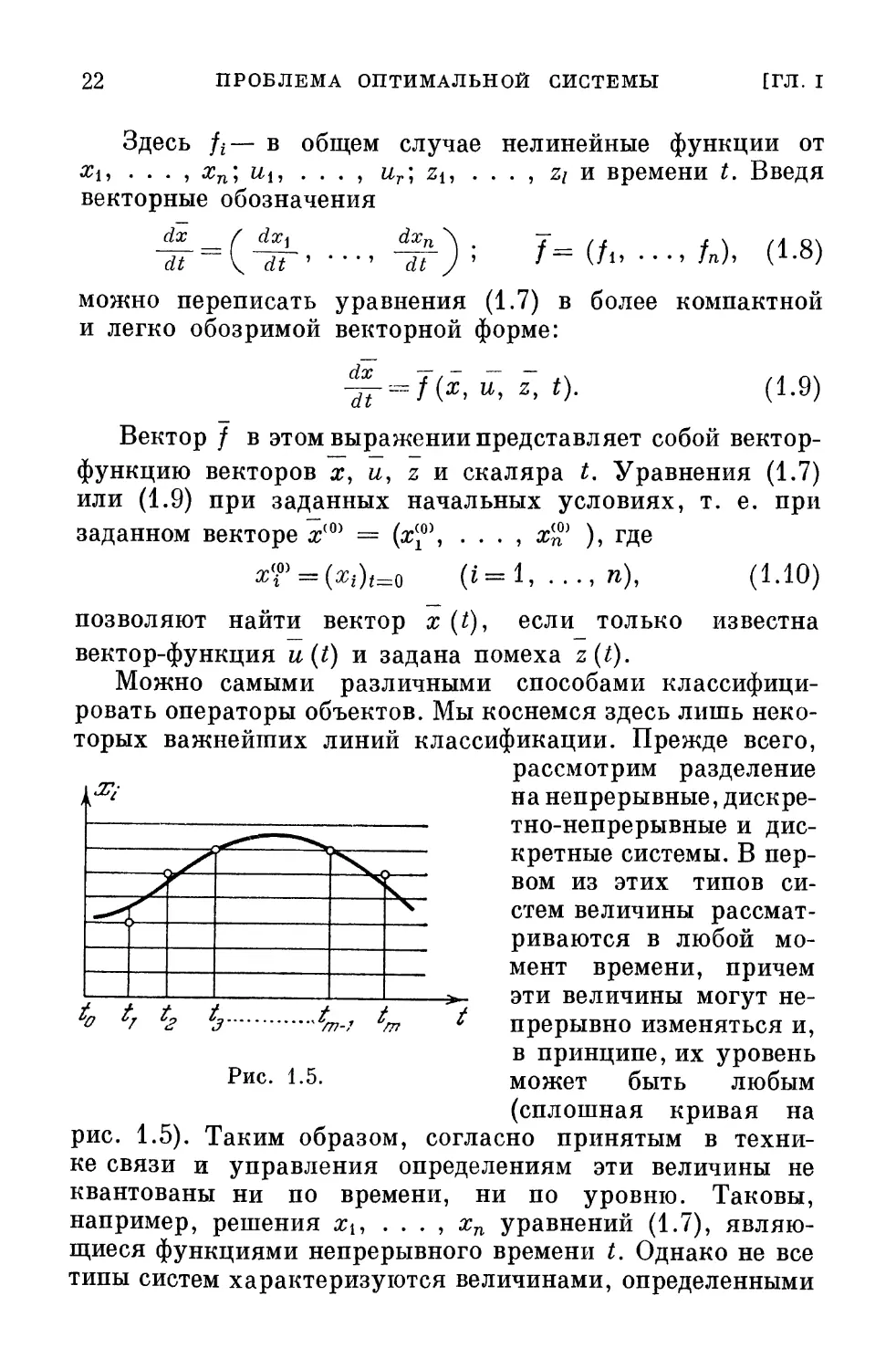

Можно самыми различными способами

классифицировать операторы объектов. Мы коснемся здесь лишь

некоторых важнейших линий классификации. Прежде всего,

рассмотрим разделение

на непрерывные,

дискретно-непрерывные и

дискретные системы. В

первом из этих типов

систем величины

рассматриваются в любой

момент времени, причем

эти величины могут

непрерывно изменяться и,

в принципе, их уровень

Рис. 1.5. может быть любым

(сплошная кривая на

рис. 1.5). Таким образом, согласно принятым в

технике связи и управления определениям эти величины не

квантованы ни по времени, ни по уровню. Таковы,

например, решения хи . . . , хп уравнений A.7),

являющиеся функциями непрерывного времени t. Однако не все

типы систем характеризуются величинами, определенными

и,;

>

/77-7 /77

§ 2] КЛАССИФИКАЦИЯ ОПТИМАЛЬНЫХ СИСТЕМ 23

в любой момент времени. В импульсных и цифровых

системах управления, а также при применении импульсной

модуляции для передачи сигналов представляют интерес

лишь значения величин в дискретные моменты времени

t = t0, tu t2, ... Если при этом дозволены любые уровни

величин, то это означает, что последние квантованы по

времени, но не квантованы по уровню. Соответствующие

системы называются дискретно-непрерывными. Оператор

дискретно-непрерывной системы может быть задан,

например, уравнениями в конечных разностях. Обозначим

через xt (т) значение величины хг в момент времени t= tm

(см. рис. 1.5). Обозначим, далее, через

x(m)=[xi(m), ...,хп(т)] A.11)

вектор х в момент t = tm, а через и (т) — вектор и при

t = tm. Тогда уравнения в конечных разностях,

связывающие последующие значения хг (т + 1) с

предыдущими хг (т), могут быть записаны в следующем виде:

), . . ., хп(т); щ(т), . . ., иг(т);

Zi(m), ..., zi(m); m] (i=l, . .., и), A.12)

где gf— вообще говоря, нелинейные функции своих

аргументов. Уравнения A.12) можно записать в векторном виде-

x(m + l) = ~g[x(m); u(m); z(m); m]. A.13)

Здесь g — вектор с составляющими g{, . . . , gn.

В третьем типе систем дозволены лишь определенные

дискретные уровни величин (сетка дозволенных уровней

показана на рис. 1.5). Например, возможен случай, когда

xt (m) = aq, где а —константа, a q — целое число. Тогда

значение величины хг изображается одним из дозволенных

уровней (кружки на рис. 1.5). Системы, в которых

величины квантованы и по времени и по уровню, называются

дискретными (или чисто дискретными). Оператор

дискретной системы может характеризоваться, например,

уравнениями A.12); однако все величины в этих уравнениях

должны иметь лишь дозволенные уровни. В частности,

и функции gt могут принимать лишь дозволенные для хг

значения.

24 ПРОБЛЕМА ОПТИМАЛЬНОЙ СИСТЕМЫ [ГЛ. I

Непрерывным оптимальным системам посвящено

наибольшее количество работ (см., например, [3.2, 3.14, 3.16—

3.18, 3.21-3.23]).

Дискретно-непрерывные оптимальные системы

рассматривались в [3.19, 3.20, 3.24, 3.30, 3.31]. Чисто

дискретным оптимальным системам посвящена работа [4.12].

Можно различать объекты и по типам их уравнений.

В большинстве работ по оптимальным системам изучаются

объекты с сосредоточенными параметрами, движение

которых характеризуется обыкновенными дифференциальными

уравнениями. Однако в [3.42] был поставлен, а в [3.43,

3.44] решался ряд задач для объектов с распределенными

параметрами, характеризующихся уравнениями в частных

производных и интегральными уравнениями.

В число характеристик объекта В входят также огра-

ничения'у&зличного вида. Например, управляющие

воздействия ии . . . , иг, входящие в состав вектора и (см.

рис. 1.3), не могут иметь любые значения. Они не могут

вследствие физических свойств объекта или не должны —

допустим, из-за опасности нарушения нормальной работы

объекта — превышать некоторые пределы.

Весьма часто ограничения имеют вид

Ы<ии ..., \ur\<Ur, A.14)

где С/ь . . . , UT— заданные константы. Возможен

случай, когда ограничены функции от нескольких

управляющих воздействий, например:

2AT, ' AЛ5)

v=i

где %% и N — константы либо заданные функции времени.

Рассмотрим r-мерное пространство вектора и с

декартовыми координатами щ, . . . , ит. Условия A.14)

или A.15) являются частными случаями условий,

ограничивающих расположение конца вектора и некоторой

допустимой областью Q (и) этого пространства.

Выражение «и принадлежит области Q (и)» символически

записывают в следующем виде:

. A.16)

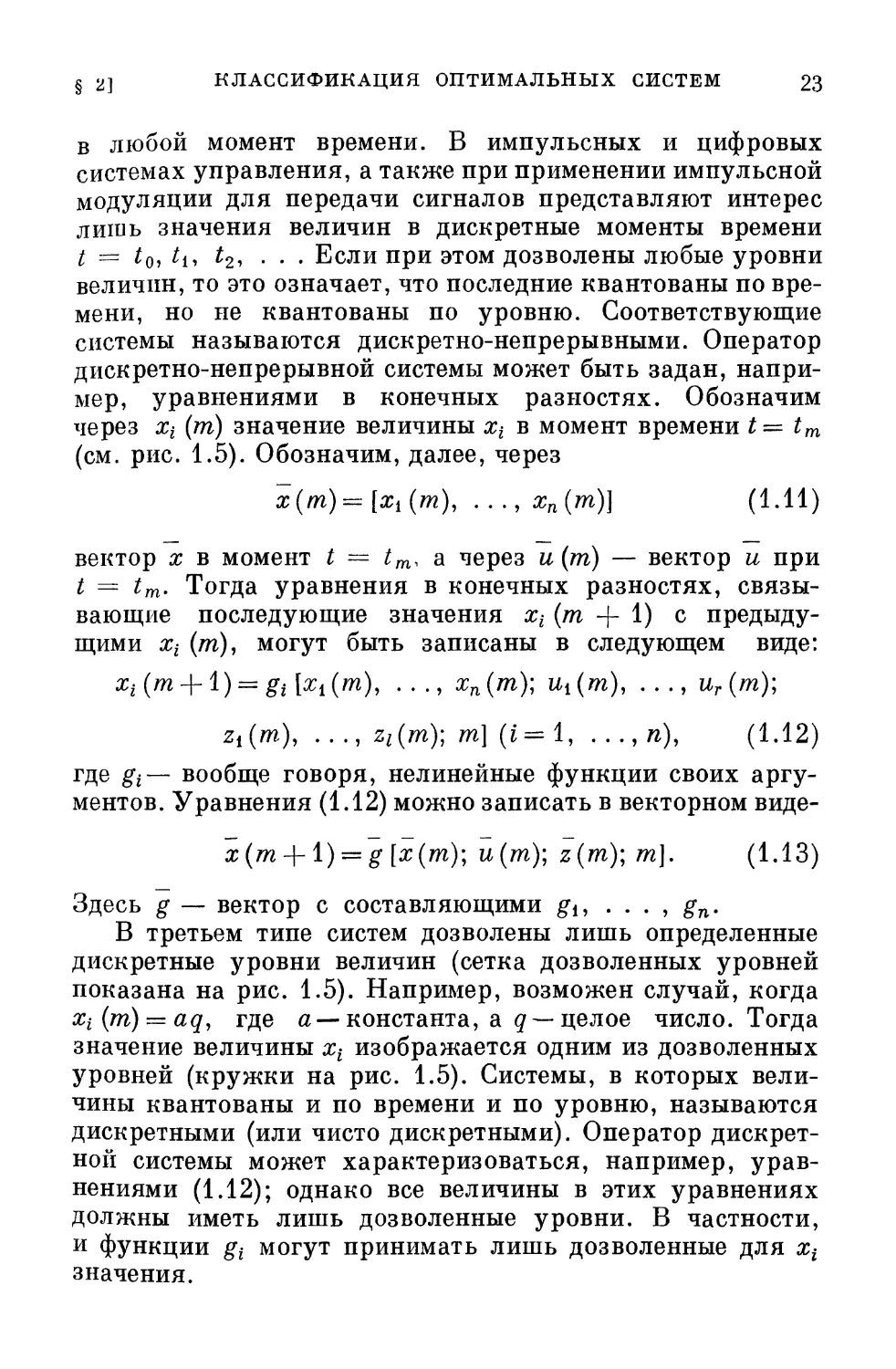

§ 2] КЛАССИФИКАЦИЯ ОПТИМАЛЬНЫХ СИСТЕМ 25

В частном случае условий A.14) вектор и ограничен

r-мерным параллелепипедом, а в случае условий A.15) —

r-мерным эллипсоидом в ^-пространстве.

Ограничения могут быть наложены не только на

управляющие воздействия Uj, но и на координаты х% (i = 1, ...

. . . , п) объекта В. Например, какие-либо заданные

функции или функционалы Н^ (х) этих координат не

должны превосходить некоторые пределы, которые можно

без ограничения общности принять равными нулю:

#и(*ь •••» О = #йЙ<0 (|i = l, ..., т). A.17)

Функции или функционалы Н^ (х) можно считать

координатами m-мерного вектора Н (х). Условия A.17)

накладывают ограничения на расположение этого вектора.

Если Яй — однозначные функции х, то условия A.17)

означают, что и вектор х ограничен в тг-мерном ж-про-

странстве некоторой допустимой областью Q (х):

*бО(ж). A.18)

В наиболее общем случае ограничиваются некоторые

функционалы L от и (/), x(t) и z (t), т. е* величины,

зависящие от вида функций и, х, z на каком-либо интервале:

Ый@, 5@, г@]е0цA0 ([x = i,..., m), A.19)

где Qjj, (L) — допустимая область изменения функционала

L^. Примером может служить ограничение вида

Т п

] dt^N, A.20)

'v=i

где Г, av, р и N — положительные константы*). В

дискретно-непрерывных или дискретных системах

ограничиваются аналогичные величины.

Ограничения чрезвычайно важны при проектировании

управляющих устройств. Поясним это положение

примером. Пусть требуется построить следящую систему

постоянного тока с минимальным временем переходного процесса.

*) В формулу ограничения может входить также время t

в явном виде

26 ПРОБЛЕМА ОПТИМАЛЬНОЙ СИСТЕМЫ [ГЛ. I

В принципе, подавая сколь угодно большие напряжения

на вход цепи якоря сервомотора, можно получать сколь

угодно большие токи в этой цепи, сколь угодно большие

моменты и ускорения вала двигателя, что обеспечит

сколь угодно малое время переходного процесса. Однако

допустимы лишь такие процессы, в которых ток якоря,

а также скорость вала сервомотора не выйдут за некоторые

определенные пределы. Именно это обстоятельство не

позволяет беспредельно уменьшить время переходного

процесса (см., например, рис. 1.2). Вообще, наличие

ограничений придает во многих случаях смысл задаче

об оптимальной системе. Решение этой задачи должно

ответить на вопрос: как добиться наилучших результатов

при ограниченных ресурсах.

К характеристикам объекта В можно отнести также

характеристики возмущения z, действующего на объект

от внешней среды — см. рис. 1.3 и уравнения A.7), A.9).

Иногда характеристики возмущения включают в состав

оператора объекта. Если zv— известные функции

времени (v = 1, . . . , /), то их выражения можно

подставить в уравнения объекта В, например в уравнения A.7)

или A.12). Тогда эти уравнения будут явно зависеть

от времени. В методических целях удобно

непредвиденные возмущения zv считать внешними воздействиями,

прилагаемыми извне к объекту, а все возмущения,

предполагаемые известными, включать в состав оператора F.

Возмущения zv могут, складываясь с другими

воздействиями, например с u,j, поступать на входы звеньев

объекта В. Эти воздействия называют аддитивными.

Но zv могут действовать и по-другому, изменяя

коэффициенты уравнений звеньев или их параметры. Такие

воздействия называются параметрическими. В

нелинейных системах, вообще говоря, отсутствует четкое

различие между этими двумя типами воздействий.

Случайные возмущения zv могут быть случайными

величинами или случайными процессами, которые

рассматриваются в главе П. В первом случае zv могут

считаться постоянными в течение одного отдельного процесса

в системе; во втором случае zv представляют собой

случайные функции времени, изменением которых за время

одного процесса в системе нельзя пренебречь.

§ 3] КРИТЕРИИ ОПТИМАЛЬНОСТИ 27

Иногда случайные возмущения zv не фигурируют явно

в условиях задачи. Но если z случайно, то при заданном и,

согласно A.7), выходная величина х объекта В будет

случайным процессом. Можно задать вместо

характеристики z непосредственно условные вероятностные

характеристики процесса х, зависящие от и и начальных

условий я0, что заменяет сразу задание оператора F и

характеристик случайного возмущения z. Таким способом

задан объект, например, в [4.12].

§ 3. Критерии оптимальности

Требования, предъявляемые к поведению объекта Б,

представляют собой второе направление классификации

оптимальных систем (см. рис. 1.4). В состав этих

требований входит задание определенной цели управления.

В любом случае цель управления можно рассматривать

как достижение экстремума некоторой величины Q —

критерия оптимальности. В зависимости от требований

необходим либо максимум, либо минимум величины Q.

В общем случае критерий оптимальности зависит как

от задающего воздействия я*, так и от выходной величины

х; он может зависеть также от и и z, а также от времени t.

Пусть для определенности требуется, чтобы величина Q

была минимальна:

Q(x, ж*, и, г, t) = min. A.21)

Это условие представляет собой аналитическую

формулировку цели управления. Отметим, что Q является

функционалом, т. е. числом, зависящим от вида функций

х, х*, и, z. Например, в частном случае Q имеет вид

т

Q=\[x(t)-x*(t)\*dt, A.22)

О

где Т — фиксированная величина. Из формулы A.22)

видно, что величина Q зависит от вида функций х (t)

и х* (t) на интервале 0< t < Т.

В качестве критерия Q могут быть выбраны различные

технические или экономические показатели — например,

28 ПРОБЛЕМА ОПТИМАЛЬНОЙ СИСТЕМЫ [ГЛ. I

производительность объекта или качество продукции,

либо затрата сырья или электроэнергии и т. д.

Обоснование выбора критерия оптимальности Q, определяемого

конкретными технико-экономическими условиями,

находится вне рамок теории оптимальных систем и в этой теории

не обсуждается.

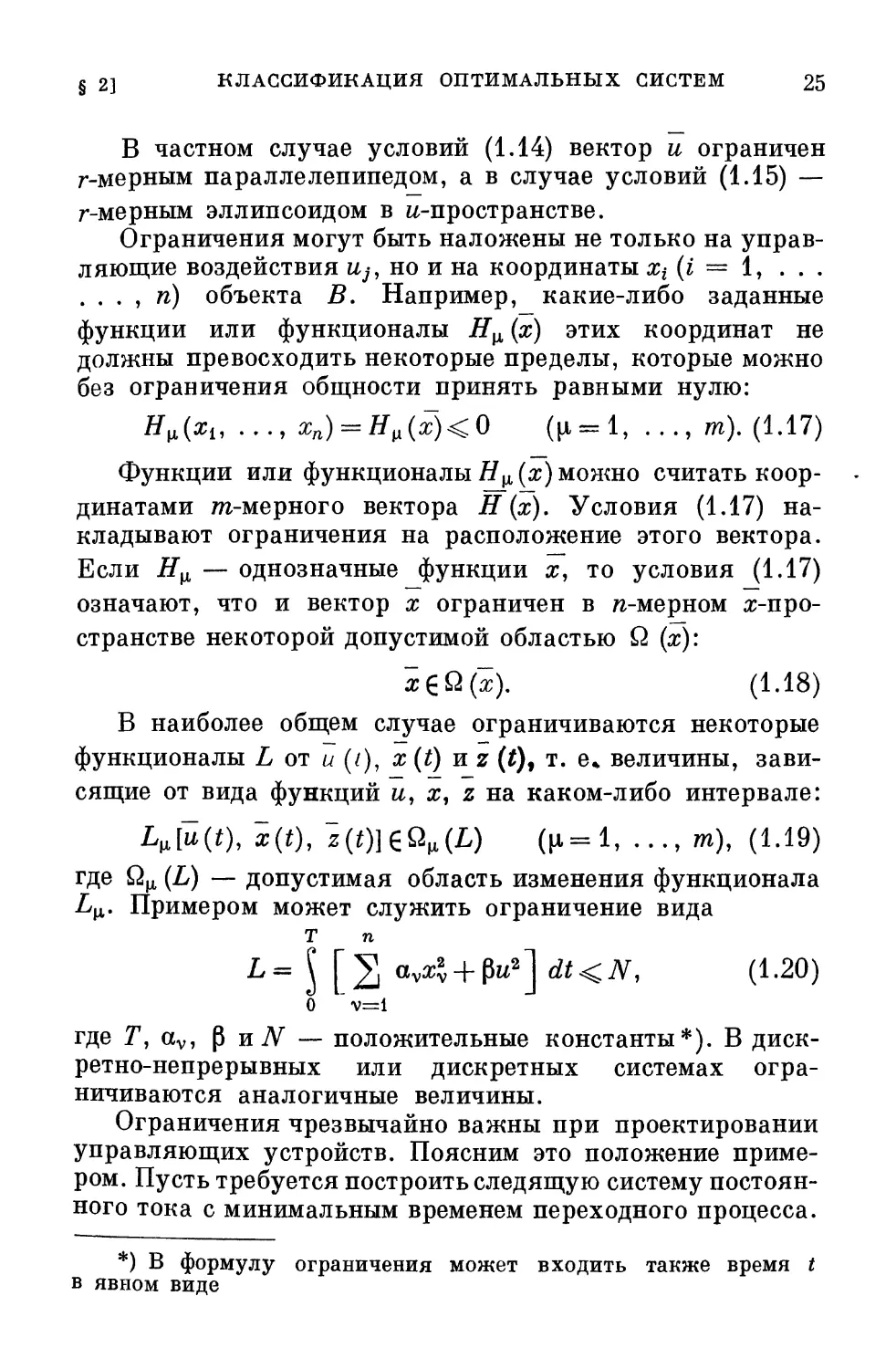

Из формулы A.21) для Q можно

узнать не только возможное

минимальное значение (?min» но и оценить

Рис. 1.6 ухудшение работы системы при

отклонении ее от идеала. Мерой

ухудшения может явиться разность Q — Qmin или какая-

нибудь монотонная функция этой разности, обращающаяся

в нуль при Q = Qmin.

Возможны различные линии классификации по типам

критериев Q. Так, можно делить критерии оптимальности

в зависимости от того, относятся они к переходному

или установившемуся процессу в системе. Для примера

рассмотрим интегральные критерии процессов в линейных

системах. Пусть движение некоторой линейной системы с

входной величиной х* и выходной величиной х (рис. 1.6)

характеризуется линейным дифференциальным уравнением с

постоянными коэффициентами, связывающим входную

величину х* с выходной х:

dnx dn~~lx '

ao-di^ + ui dtn-i + ••• +anx =

= bo^r+ ...+ bmx*. A.23)

Решение этого уравнения имеет, как известно, вид

A.24)

где xs (t) — частное решение уравнения с правой частью,

a Xd (t) — общее решение уравнения без правой части

Физический смысл формулы A.24) состоит в том, что

х8 (?), при определенных дополнительных условиях,

представляет собой установившийся процесс в системе, а

х<1 @ — переходный процесс. Если система устойчива,

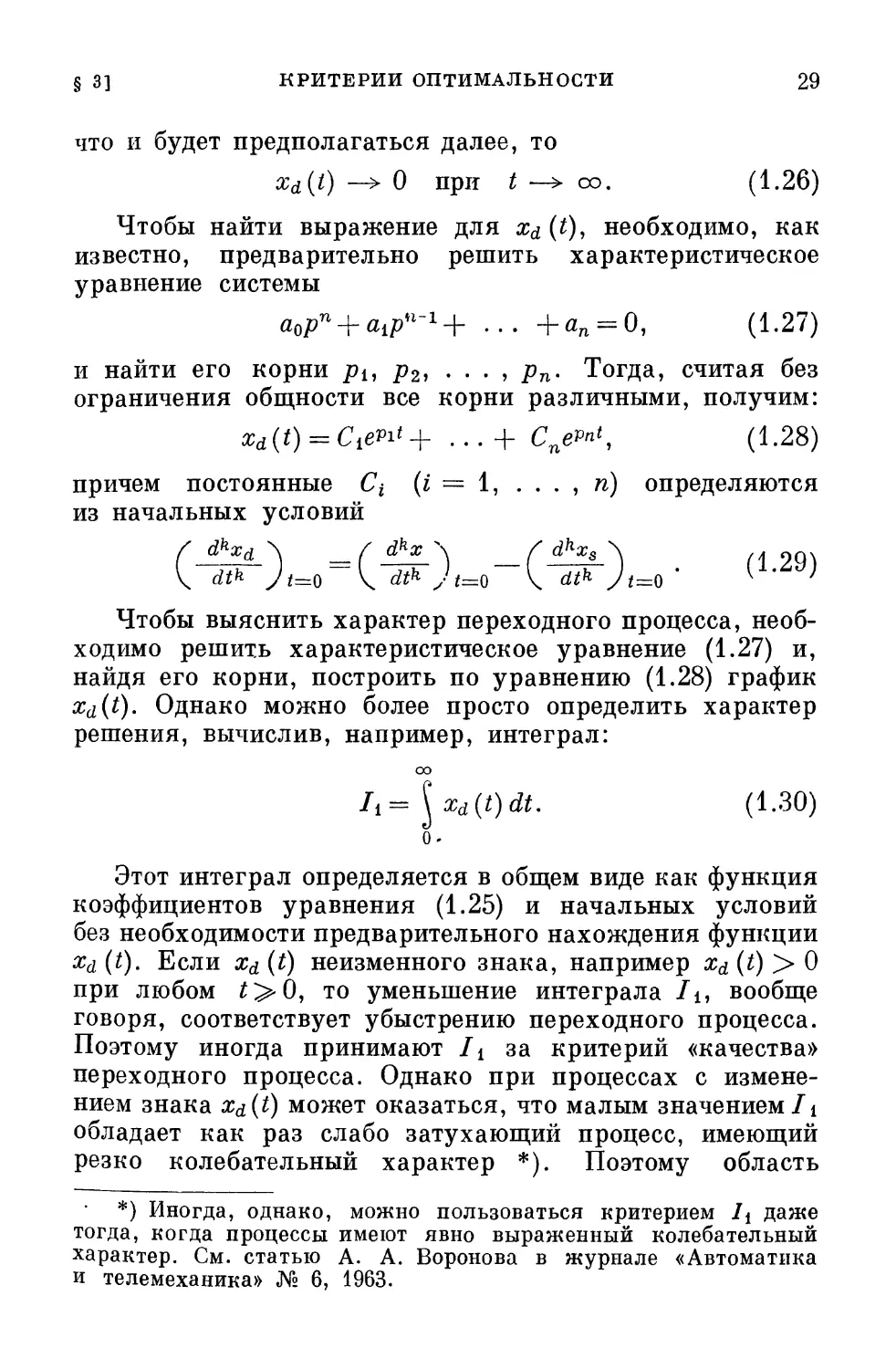

§ 3] КРИТЕРИИ ОПТИМАЛЬНОСТИ 29

что и будет предполагаться далее, то

Xd(t) __> 0 при t -> со. A.26)

Чтобы найти выражение для xd (t), необходимо, как

известно, предварительно решить характеристическое

уравнение системы

аорп + а1рп~1+ ... +а„ = 0, A.27)

и найти его корни pt, р2, . . . , рп. Тогда, считая без

ограничения общности все корни различными, получим:

A#28)

причем постоянные С% (i = 1, . . . , п) определяются

из начальных условий

Чтобы выяснить характер переходного процесса,

необходимо решить характеристическое уравнение A.27) и,

найдя его корни, построить по уравнению A.28) график

Xd(t). Однако можно более просто определить характер

решения, вычислив, например, интеграл:

оо

= \xd{t)dt. A.30)

о

Этот интеграл определяется в общем виде как функция

коэффициентов уравнения A.25) и начальных условий

без необходимости предварительного нахождения функции

xd (t). Если ха (t) неизменного знака, например xd (t) > 0

при любом ?>0, то уменьшение интеграла /ь вообще

говоря, соответствует убыстрению переходного процесса.

Поэтому иногда принимают It за критерий «качества»

переходного процесса. Однако при процессах с

изменением знака xa(t) может оказаться, что малым значением/i

обладает как раз слабо затухающий процесс, имеющий

резко колебательный характер *). Поэтому область

*) Иногда, однако, можно пользоваться критерием /4 даже

тогда, когда процессы имеют явно выраженный колебательный

характер. См. статью А. А. Воронова в журнале «Автоматика

и телемеханика» № 6, 1963.

30 ПРОБЛЕМА ОПТИМАЛЬНОЙ СИСТЕМЫ [ГЛ. I

применения критерия /i ограничена. В [1.3] был

предложен другой критерий:

/2= ^xl(t)dt. A.31)

о

Подбирая параметры или алгоритм управляющего

устройства А с целью минимизации интеграла /2, часто

можно добиться удовлетворительного характера

переходного процесса. Критерий /2 был применен к

системам автоматического регулирования [1.4, 1.5]. Однако

нередко применение этого критерия приводит все же

к излишне колебательному характеру переходного

процесса [1.6]. Поэтому в [1.6] был предложен так

называемый обобщенный интегральный критерий

оо

/v= J Vdt, A.32)

о

где V — квадратичная форма от переходных

составляющих xdi координат Xi, . . . , хп системы:

п

V= S auzdizdj. A.33)

Поясним геометрический смысл обобщенного

интегрального критерия на простейшем примере, в котором

х^ — переходная составляющая погрешности системы,

dxjA

Xdi = xu —fi- = ^2 . Пусть

(^)8], A.34)

\

о

где Т = const.

Выбирая параметры системы так, чтобы

минимизировать интеграл /у, мы запрещаем длительное

существование значительных отклонений xdl (иначе составляющая

оо

\ xdl dt интеграла /у будет велика), но также запреща-

о

ем и длительное существование больших значений про-

§ 3] КРИТЕРИИ ОПТИМАЛЬНОСТИ 31

dxd s г» / dxd \2

изводных l ( иначе составляющая \ I —y^- ) at инте-

0

грала Iу будет велика). Таким образом, получается

не только быстрый, но и плавный, без резких колебаний,

переходный процесс.

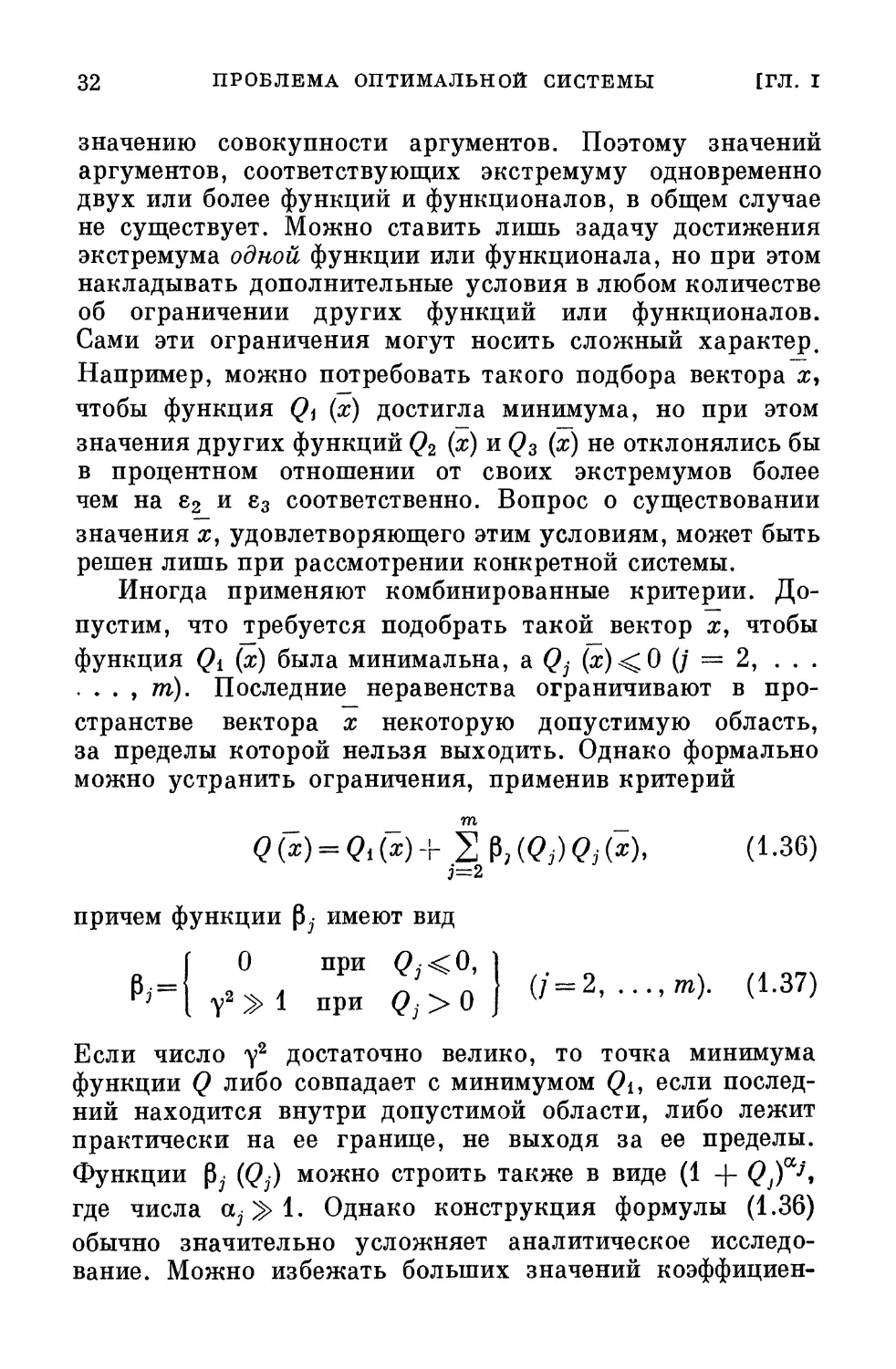

Интеграл Iv принципиально отличается от /4 и /2

тем, что дает возможность по величине /у составить

строгое суждение о характере переходного процесса.

Более подробно этот вопрос рассматривается в главе П.

Критерии A.30) — A.32) служат для оценки

переходного процесса xd(t). Для оценки установившегося

процесса xs (t) служат критерии другого типа, например,

т т

4р. кв = Hm±? \ х2 (t)dt = lim ^г [ х\ (t) At +

Т-»со л jj T->oo L J

Т Т

+ lim 4* [ xl(t)At-\- lim -^ \ xsxddl. A.35)

Второе слагаемое в правой части A.35) равно нулю,

т

так как интеграл \ х\ (t) At остается конечным при Т—> оо.

о

Нетрудно видеть, что и последнее слагаемое исчезает.

Поэтому остается лишь первое слагаемое,

соответствующее установившемуся процессу xs (t).

Другие типы критериев оптимальности для

переходных и установившихся процессов описаны в [1.7—1.9].

Часто критерием оптимальности в переходном

процессе считают время регулирования или величину

максимального отклонения процесса от некоторой заданной

величины или функции времени. В последнем случае

требуется, чтобы в оптимальной системе достигался

минимум максимального отклонения, так называемый минимакс.

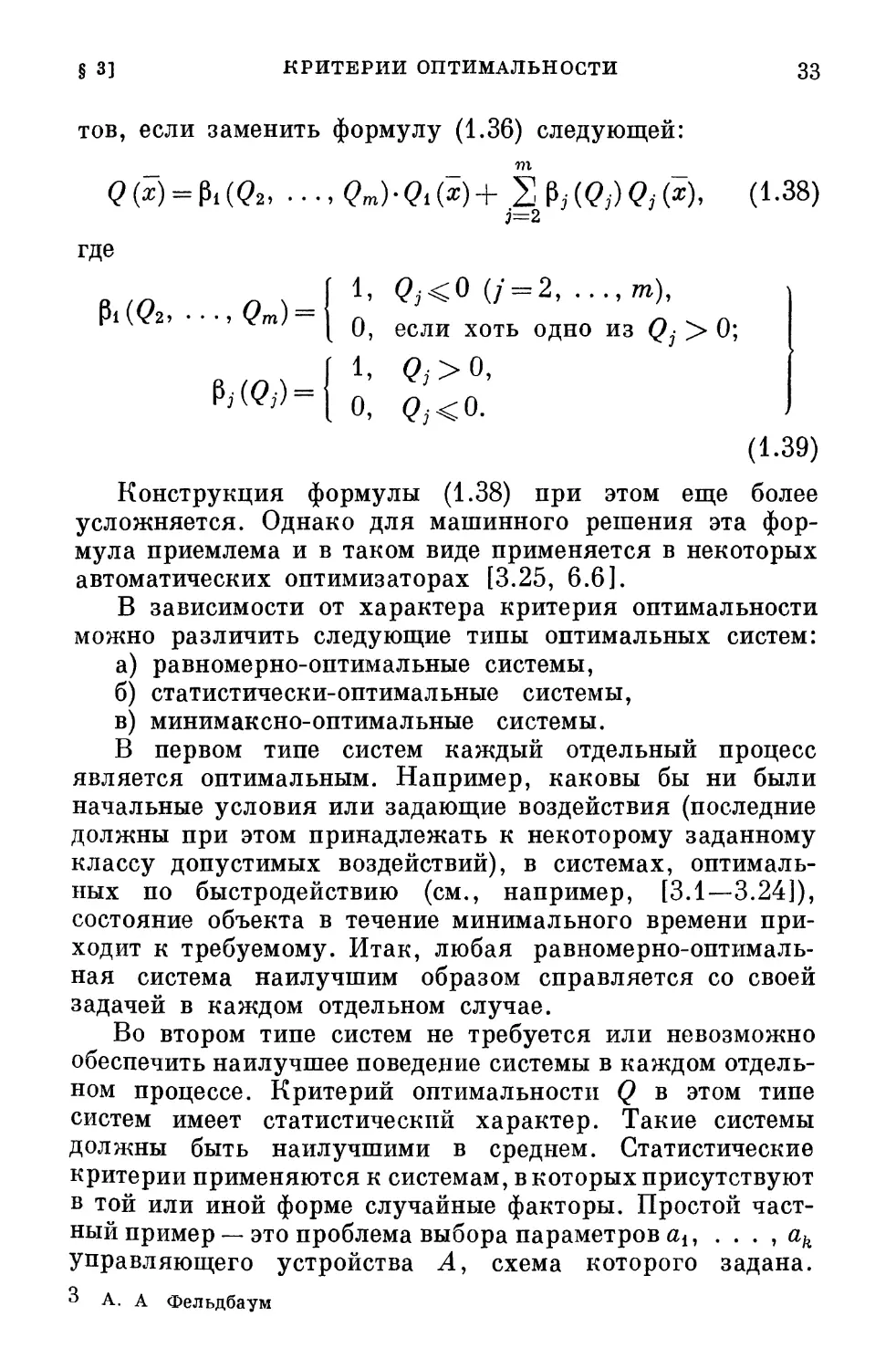

Важно подчеркнуть, что нельзя ставить задачу

одновременного достижения экстремума для двух или более

Функций одного или нескольких переменных.

Действительно, вообще говоря, экстремумы у различных функций

или функционалов не соответствуют одному и тому же

32 ПРОБЛЕМА ОПТИМАЛЬНОЙ СИСТЕМЫ [ГЛ. I

значению совокупности аргументов. Поэтому значений

аргументов, соответствующих экстремуму одновременно

двух или более функций и функционалов, в общем случае

не существует. Можно ставить лишь задачу достижения

экстремума одной функции или функционала, но при этом

накладывать дополнительные условия в любом количестве

об ограничении других функций или функционалов.

Сами эти ограничения могут носить сложный характер.

Например, можно потребовать такого подбора вектора х,

чтобы функция Qi (x) достигла минимума, но при этом

значения других функций Q2 (x) и Q3 (x) не отклонялись бы

в процентном отношении от своих экстремумов более

чем на е2 и е3 соответственно. Вопрос о существовании

значения х, удовлетворяющего этим условиям, может быть

решен лишь при рассмотрении конкретной системы.

Иногда применяют комбинированные критерии.

Допустим, что требуется подобрать такой вектор х, чтобы

функция Qi (х) была минимальна, а (?; (ж)<0 (/ = 2, ...

. . . , т). Последние неравенства ограничивают в

пространстве вектора х некоторую допустимую область,

за пределы которой нельзя выходить. Однако формально

можно устранить ограничения, применив критерий

_

2 Р, (?№(*). С1-36)

3=2

причем функции |3;- имеют вид

О при <?^<О,

при <?,><> j О-2' •••'-)• <*-37>

Если число у2 достаточно велико, то точка минимума

функции Q либо совпадает с минимумом Qi, если

последний находится внутри допустимой области, либо лежит

практически на ее границе, не выходя за ее пределы.

Функции Р; (Qj) можно строить также в виде A + QjTJ>

где числа а; > 1. Однако конструкция формулы A.36)

обычно значительно усложняет аналитическое

исследование. Можно избежать больших значений коэффициен-

§ 3] КРИТЕРИИ ОПТИМАЛЬНОСТИ 33

тов, если заменить формулу A.36) следующей:

т

Q(x) = MQ2, ..-,Qm)-Qi{x)+ 2 М?,)<?,(*)- A-38)

3=2

где

1. <?;<0 (/ = 2, ...,т),

Pi @2, ...,<?m) =

I

j j I o,

A.39)

Конструкция формулы A.38) при этом еще более

усложняется. Однако для машинного решения эта

формула приемлема и в таком виде применяется в некоторых

автоматических оптимизаторах [3.25, 6.6].

В зависимости от характера критерия оптимальности

можно различить следующие типы оптимальных систем:

а) равномерно-оптимальные системы,

б) статистически-оптимальные системы,

в) минимаксно-оптимальные системы.

В первом типе систем каждый отдельный процесс

является оптимальным. Например, каковы бы ни были

начальные условия или задающие воздействия (последние

должны при этом принадлежать к некоторому заданному

классу допустимых воздействий), в системах,

оптимальных по быстродействию (см., например, [3.1—3.24]),

состояние объекта в течение минимального времени

приходит к требуемому. Итак, любая

равномерно-оптимальная система наилучшим образом справляется со своей

задачей в каждом отдельном случае.

Во втором типе систем не требуется или невозможно

обеспечить наилучшее поведение системы в каждом

отдельном процессе. Критерий оптимальности Q в этом типе

систем имеет статистический характер. Такие системы

должны быть наилучшими в среднем. Статистические

критерии применяются к системам, в которых присутствуют

в той или иной форме случайные факторы. Простой

частный пример — это проблема выбора параметров аи . . . , ак

управляющего устройства А, схема которого задана.

3 А. А Фельдбаум

34 ПРОБЛЕМА ОПТИМАЛЬНОЙ СИСТЕМЫ [ГЛ. J

Допустим, что первичным критерием качества является

какая-либо скалярная функция

<?, = <?,(«!, ...,ak; <\ ...,х<°>) = <?(а, 3>). A.40)

Здесь #(°) — вектор начальных условий х™ (i = 1, . . . , п)

объекта В, а а — вектор параметров с координатами

dj G = 1. • • > к)-

Критерий Qi не может служить непосредственно для

выбора параметров а;, так как значения а, наилучшие для

одного типа начальных условий #(°), оказываются, вообще

говоря, не наилучшими для другого типа. Однако если

известна априорная плотность вероятности Р (я@)) для

вектора начальных условий, то критерием может служить

Q — математическое ожидание или, как принято его

называть в физике и технике, среднее значение величины

Qi. Обозначим буквой М математическое ожидание. Тогда,

согласно главе II,

В этой формуле Q (х^) — область изменения вектора х°,

а бШ (#@)) — ее бесконечно малый элемент.

Физический смысл этой оценки состоит, как известно,

в том, что при массе опытов, производимых с системой,

величина Q практически совпадает со средним

арифметическим значений Qit полученных для каждого из опытов.

Оптимальной системой при такой постановке задачи

будем считать систему, параметры которой аг

обеспечивают минимум величины Q (в общем случае, при учете

еще дополнительных ограничений).

В рассмотренном примере случайные начальные

значения для переходного процесса можно представить как

результат воздействия на объект в начальный момент

времени коротких случайных импульсов. Таким образом,

в данном случае имеется частный случай действия на

объект случайной помехи z. Можно привести и другой

простой пример системы с первичным критерием

оптимальности типа Qi (x, х*, и, z), где помеха z — случай-

§ 3] КРИТЕРИИ ОПТИМАЛЬНОСТИ 35

ная величина с плотностью вероятности jP (z). Тогда

можно выбрать в качестве критерия оптимальности

среднее значение Q величины Q^:

Qi(i, **, й, z)P(z~)dQ(z~), A.42)

где Q (z) — область изменения вектора помехи z, a

dQ, (z) — ее бесконечно малый элемент.

Оптимальные системы со статистическими критериями

оптимальности рассматривались в ряде работ (см.,

например, [1.10], [1.11], [1.12], [1.13]). Подробнее этот вопрос

изложен в главах IV — VI.

В качестве статистического критерия чаще всего

фигурирует среднее значение какого-либо первичного

критерия. В некоторых работах статистическими

критериями являются вероятности выхода величин хг за

некоторые заданные пределы или вероятности аварии

системы.

Системы третьего типа, называемые

минимаксно-оптимальными, обеспечивают наилучший по сравнению с другой

системой результат только лишь в наихудшем случае.

Иначе говоря, наихудший результат в

минимаксно-оптимальной системе лучше, чем наихудший результат в

любой другой системе. Такая постановка задачи бывает

иногда уместной в случае отсутствия априорных

вероятностных распределений. Она рассмотрена в главе V.

Характер требований к системе в значительной мере

определяется видом функции х*, входящей в формулу для

Q A.21). В эту функцию, называемую, как указано выше,

задающим воздействием, входит все заранее

непредвиденное в цели управления (если не считать влияния помехи z).

Если х*— регулярная, заранее известная функция, то ее

можно включить в состав функционала Q, и она не будет

фигурировать в явном виде. Однако на практике многое

в цели управления часто не определено заранее. Такова,

например, ситуация для следящей системы при

слежении за целью, будущее движение которой неизвестно.

В такой системе нужно поддерживать малое значение

разности [х* (t) — х (t)], причем х* (t) — случайная, не

3*

36 ПРОБЛЕМА ОПТИМАЛЬНОЙ СИСТЕМЫ [ГЛ. I

известная заранее функция времени. Если критерий

оптимальности (?i зависит от случайной функции, то чаще

всего за окончательный критерий Q принимают

математическое ожидание М {Qi} = Q.

§ 4. Ввод информации об управляемом объекте

в управляющее устройство

Важным направлением классификации является

разделение по характеру информации об управляемом

объекте 5, поступающей в управляющее устройство А или

запасенной в нем до начала процесса управления.

Прежде всего необходимо ввести деление на системы

с полной и неполной информацией об объекте. Из

вышеизложенного (см. также рис. 1.3) видно, что информация

об управляемом объекте складывается из:

а) информации о его операторе, т. е. о зависимости F

A.6);

б) информации о возмущении z, действующем на

объект В;

в) информации о состоянии объекта В, например о всех

величинах Xi, . . . , хп для объекта, движение которого

характеризуется уравнениями A.7);

г) информации о цели управления, т. е. о функционале

Q A-21);

д) информации о задающем воздействии х*.

Полная информация о любой зависимости означает

абсолютно точное ее знание. Так, полная информация

о какой-либо функции времени / (т) означает, что

известно или может быть в случае надобности определено ее

точное значение в любой момент времени при — со <

< т < оо. Например, если функция / (т) задана формулой,

то полная информация о функции означает, что заданы

все коэффициенты, входящие в состав формулы. Если все

виды информации об объекте В, указанные выше, известны

заранее управляющему устройству или обеспечиваются

поступающей на него текущей информацией, то

рассматриваемая система является системой с полной информацией

об объекте. Таков, например, частный случай, когда

в управляющее устройство А заложены априорные све-

§ 4] ВВОД ИНФОРМАЦИИ В УПРАВЛЯЮЩЕЕ УСТРОЙСТВО 37

дения об операторе F объекта в форме уравнений A.7)

и о цели Q управления, когда z и х* заранее известны,

а текущая информация о состоянии х объекта вводится

в управляющее устройство А по цепи обратной связи.

В этом случае имеем систему с полной информацией

об объекте В. Действительно, коль скоро известны z и F,

то при заданном состоянии х и контролируемом

управляющим устройством А воздействии и все поведение объекта В

в будущем предопределено. Однако далеко не всегда

задача может быть идеализирована настолько, чтобы считать,

что имеется полная информация об объекте. Например,

в разомкнутых системах отсутствует цепь обратной связи,

а следовательно, в управляющее устройство не

поступает информация о действительном состоянии объекта.

Фактически в любых системах автоматического

управления информацию об объекте нельзя считать полной,

и часто отсутствие того или иного вида информации

чрезвычайно существенно. Вернемся опять к рис. 1.3; на нем

можно увидеть ряд каналов, сквозь которые

неопределенность проникает в автоматическую систему.

Во-первых, это — канал задающего воздействия ж*, которое

во многих случаях заранее не известно. Допустим, что

требуется обеспечить равенство х = я*. Такого типа

требование встречается, например, в задачах о погоне

«собаки» за «зайцем». В качестве «собаки» и «зайца» могут

фигурировать различные автоматы, например ракеты.

Каково оптимальное поведение «собаки», преследующей

«зайца»? Ясно, что она должна бежать наперерез «зайцу»,

а для этого необходим прогноз будущей траектории

«зайца» на основании анализа его поведения в прошлом.

Но никакой прогноз не может быть совершенно точным.

Следовательно, здесь находится тот канал, сквозь который

проникает неопределенность и связанные с ней

статистические методы подхода. Другой канал — это помеха z,

представляющая случайные, заранее не предвиденные

изменения характеристик объекта Z?, которые чаще всего

не поддаются непосредственному измерению. И здесь

также неопределенность и случайность влекут за собой

необходимость применения статистических методов. Этот

38 ПРОБЛЕМА ОПТИМАЛЬНОЙ СИСТЕМЫ [ГЛ. I

вид неопределенности часто оказывается наиболее

важным. В большинстве случаев именно наличие

неопределенности указанных выше типов обусловливает

необходимость в сложных видах управления. Если бы все об

объекте было известно заранее, то можно было бы

осуществить разомкнутую систему, в которой устройство А

снабжено заранее разработанной программой управления.

В этом случае вряд ли возникла бы вообще необходимость

в специальной теории управления. Между прочим, в такой

гипотетической системе не было бы никакой надобности

в цепи обратной связи.

Однако и цепь обратной связи, являясь мощным

средством увеличения помехоустойчивости системы, сама

представляет собой канал, сквозь который новые виды помех

проникают в систему. По этой цепи необходимо передавать

в управляющее устройство А данные о состоянии

объекта В, например координаты #i, . . . , хп объекта с

уравнениями A.17) либо эквивалентные им величины х,

dx dn~^x r

—т~ , . . . , dtn-i Для объекта, характеризуемого

уравнением A.23). Величину х часто можно измерить с

достаточной точностью. Однако первую и, особенно, высшие

производные либо вовсе нельзя измерить, либо, если

измерение возможно, данные получаются со значительной

погрешностью. Здесь не может помочь многократное

дифференцирование функции х (t). Действительно, с одной

стороны, все дифференциаторы создают собственные

погрешности. С другой стороны, малые помехи высоких

частот, неизбежно примешивающиеся к функции х (t),

создают большие искажения в производных, тем большие,

вообще говоря, чем больше порядок производной.

Следовательно, данные о состоянии объекта получаются

управляющим устройством А с погрешностями, иногда

весьма значительными. Таким образом, на практике

информация о состоянии объекта является неполной. Можно

представить себе эквивалентную схему, в которой данные

о состоянии объекта проникают на управляющее

устройство, проходя предварительно сквозь некоторый канал

со случайными помехами и смешиваясь с ними. Это

и есть тот третий канал, сквозь который неопределенность

проникает в систему.

§ 4] ВВОД ИНФОРМАЦИИ В УПРАВЛЯЮЩЕЕ УСТРОЙСТВО 39

Следует указать, что случайные помехи имеются

и внутри любого реального управляющего устройства А.

В устройствах непрерывного действия эту роль играют

многочисленные факторы — дрейф и шумы усилителей,

наводки и т. д. В устройствах дискретного действия,

например цифровых, эту роль играют ошибки

округления, возникающие из-за наличия конечного числа

разрядов в тех числах, которые являются результатами

элементарных операций. Однако мы в дальнейшем будем

пренебрегать ошибками в управляющем устройстве. Во-

первых, эти ошибки в большинстве случаев можно сделать

малыми. Во-вторых, их учет чрезвычайно усложнил бы

теорию. В-третьих, грубый учет ошибок управляющего

устройства можно в ряде случаев произвести, приведя

их к его входу или выходу. В этих случаях ошибки

управляющего устройства становятся тождественными ошибкам

в канале обратной связи или в канале управляющего

воздействия (либо в объекте В).

Неполнота информации об объекте вызывает

необходимость в его изучении во время самого процесса

управления. Поэтому в общем случае управляющее устройство

в автоматической системе решает две тесно связанные,

но различные по характеру задачи. Во-первых, оно на

основании приходящей к нему информации выясняет

характеристики и состояние управляемого объекта В.

Во-вторых, оно на основании найденных данных объекта .

определяет, какие действия необходимо предпринять для

успешного управления. Первая задача —это задача

изучения объекта, вторая — задача приведения объекта к

требуемому состоянию. В простейших типах систем решение

одной из этих задач может отсутствовать либо оно

производится в примитивной форме. В сложных случаях

управляющее устройство должно решать обе указанные задачи.

Можно провести аналогию между работой

управляющего устройства А и человека, который взаимодействует

с окружающей его средой. Человек изучает эту среду

для того, чтобы воздействовать на нее в полезном для

себя направлении. Но чтобы лучше направить свои

действия, он должен лучше изучить окружающий его мир.

Поэтому он иногда действует на среду не для того, чтобы

получить непосредственную пользу, а лишь с* целью

40 ПРОБЛЕМА ОПТИМАЛЬНОЙ СИСТЕМЫ [ГЛ. I

лучшего ее изучения. Итак, воздействие на среду и

изучение ее тесно переплетены между собой.

Процесс изучения управляемого объекта В имеет

определенное сходство с процессом получения человеком

новых сведений и познаний. Эти сведения могут быть

получены в готовом виде в качестве информации от

другого человека; они могут быть добыты путем наблюдения;

наконец, они могут быть найдены в результате

эксперимента. Оптимальные системы можно также разделить

на три типа, соответствующих указанным выше способам

добывания сведений:

а) оптимальные системы с полной информацией об

управляемом объекте либо с максимально возможной

информацией, см. главы III и IV;

б) оптимальные системы с неполной информацией об

объекте и независимым (или пассивным) ее накоплением

в процессе управления, см. главу V;

в) оптимальные системы с неполной информацией об

объекте и активным ее накоплением в процессе

управления (дуальное управление), см. главу VI.

Ниже принято, что в управляющем устройстве А

заложена полная априорная информация об операторе F

объекта и о цели управления, т. е. о функционале Q.

Если имеется еще полная информация о задающем

воздействии я* (т. е. полные сведения об этой величине как

в прошлом, так и в настоящем и будущем), полная

информация о помехе z (включающая, следовательно, точное

знание ее будущего) и, наконец, полная текущая

информация о состоянии х объекта в данный момент времени t

(а эта информация дает возможность узнать при заданном

и (t) все поведение объекта в будущем), то мы назовем

такую систему системой с полной информацией (в

управляющем устройстве) об управляемом объекте.

Развитие теорий систем с полной информацией об

объекте шло до последнего времени совершенно

независимо и обособленно от развития другой группы теорий,

появившейся примерно одновременно с первой группой.

Во второй группе теорий оптимальных систем априорно

известны не сами воздействия, а лишь статистические

характеристики случайных входных воздействий. Таким

§ 4] ВВОД ИНФОРМАЦИИ В УПРАВЛЯЮЩЕЕ УСТРОЙСТВО

41

Ф

образом, здесь нет полной информации об объекте.

Основная задача, рассматриваемая в теориях второй группы,

относится к системе, структурная схема которой показана

на рис. 1.7, а. Сначала вся рассчитываемая система

рассматривается как некоторый фильтр Ф. Задающее

воздействие я* поступает на этот фильтр не непосредственно,

а через канал связи или, вообще, через некоторую

заданную систему Н*, где

смешивается со

случайной помехой или

шумом А*. Таким

образом, на вход

фильтра Ф подается смесь

у* сигнала с шумом.

Задача фильтра

заключается в том, чтобы

выдать на выходе

величину х, наиболее

близкую, в некотором

ст атистиче ск ом

смысле, к х* или к

результату некоторого

известного

преобразоваX

I

"'

п

\

I

i

I

Рис. 1.7.

Ф

ния х*.

После решения

указанной выше

задачи можно решить, обычно без связи с ней, следующую

задачу о расчленении фильтра Ф на объект В и управляющее

устройство А. Эти части Ф могут быть соединены

последовательно, как на рис. 1.7, б, образуя разомкнутую систему,

либо каким-либо иным способом. Например, на рис. 1.7, в в

фильтре Ф имеется внутренняя цепь обратной связи.

Обычно объект В задан заранее, а алгоритм управляющего

устройства А следует определить. Если определяется

оптимальный фильтр Ф из класса линейных систем, то его

последующее расчленение на части А и В вызывает лишь

сравнительно небольшие и обычно непринципиальные

затруднения *. Если же оптимальный фильтр Ф является

нелинейным, то задача расчленения неимоверно усложняется.

*) Тем не менее, и в этом случае задача не всегда разрешима.

42 ПРОБЛЕМА ОПТИМАЛЬНОЙ СИСТЕМЫ [ГЛ. I

В этом случае удобнее еще до начала расчета задать

структурную схему фильтра Ф, для которой определяется

алгоритм части А. Однако в области исследования нелинейных

фильтров пока сделаны лишь первые шаги (см. [1.10],

[1.11], [1.17], [1.18]). В основной массе работ в этой

области, начиная с классических исследований А. Н.

Колмогорова [1.14] и Н. Винера[1.15], ставились и решались

задачи получения оптимальных линейных систем (см.,

например, [1.10],[1.11],[1.12], [1.13], [1.16], [1.20]—[1.26]).

Вторая группа оптимальных систем, указанная выше,

характеризуется тем, что процесс накопления

информации о воздействии х* не зависит от алгоритма или, как

говорят иначе, от стратегии управляющего устройства А.

Действительно, накопление информации состоит в

наблюдении значений г/* и конструировании по ним гипотез

о процессе х*. Сам по себе процесс наблюдения не зависит

от принимаемых устройством А решений о характере

процесса #*. Информацию, получаемую от наблюдения,

можно лишь правильно использовать, но ее нельзя

увеличить, какова бы ни была стратегия управляющего

устройства. Поэтому такие системы могут быть названы

оптимальными системами с пассивным или независимым (от

стратегии управляющего устройства) накоплением информации.

Полезно различать следующие варианты задания

характеристик воздействия #*, если оно нерегулярно:

а) #* (t) — функция, принадлежащая к некоторому

известному классу, например:

где я|); (t) — известные функции, a Ct — случайные

величины с заданными вероятностными характеристиками.

Далее, h*(t) — случайная функция, вероятностные

характеристики которой известны. В таком случае, чем

дольше ведется наблюдение величины у* на выходе канала

#*, тем точнее можно предсказать будущее поведение

x*(t), например на основании] уточнения значений

коэффициентов Сг в формуле A.43).

б) x*(t) — случайная функция, для которой заданы

такие вероятностные характеристики, что точное знание

ее прошлого дает лишь возможность производить про-

§ 4] ВВОД ИНФОРМАЦИИ В УПРАВЛЯЮЩЕЕ УСТРОЙСТВО 43

гнозы относительно ее будущего. В данном случае

можно лишь уточнять эти прогнозы, наблюдая y*{t)

и уточняя по результатам наблюдений прошлые и

настоящее значения #*(?). Однако предсказание поведения

функции х*(t) никогда не может стать сколь угодно точным,

в) x*(t) — случайная функция с неизвестными,

полностью или частично, вероятностными характеристиками.

При этом задача сводится к тому, чтобы посредством

наблюдения величины у*(t) выяснить или уточнить

вероятностные характеристики x*(t), что позволит уточнить прогноз

поведения x*(t) в будущем (см., например, [5.32, 5.33]).

В работах [6.1, 6.2] рассматриваются некоторые

задачи третьей группы теорий оптимальных систем. Эта

группа имеет черты, сходные с теориями первой и второй

групп. Однако она имеет и свои специфические черты,

не присущие теориям первых двух групп.

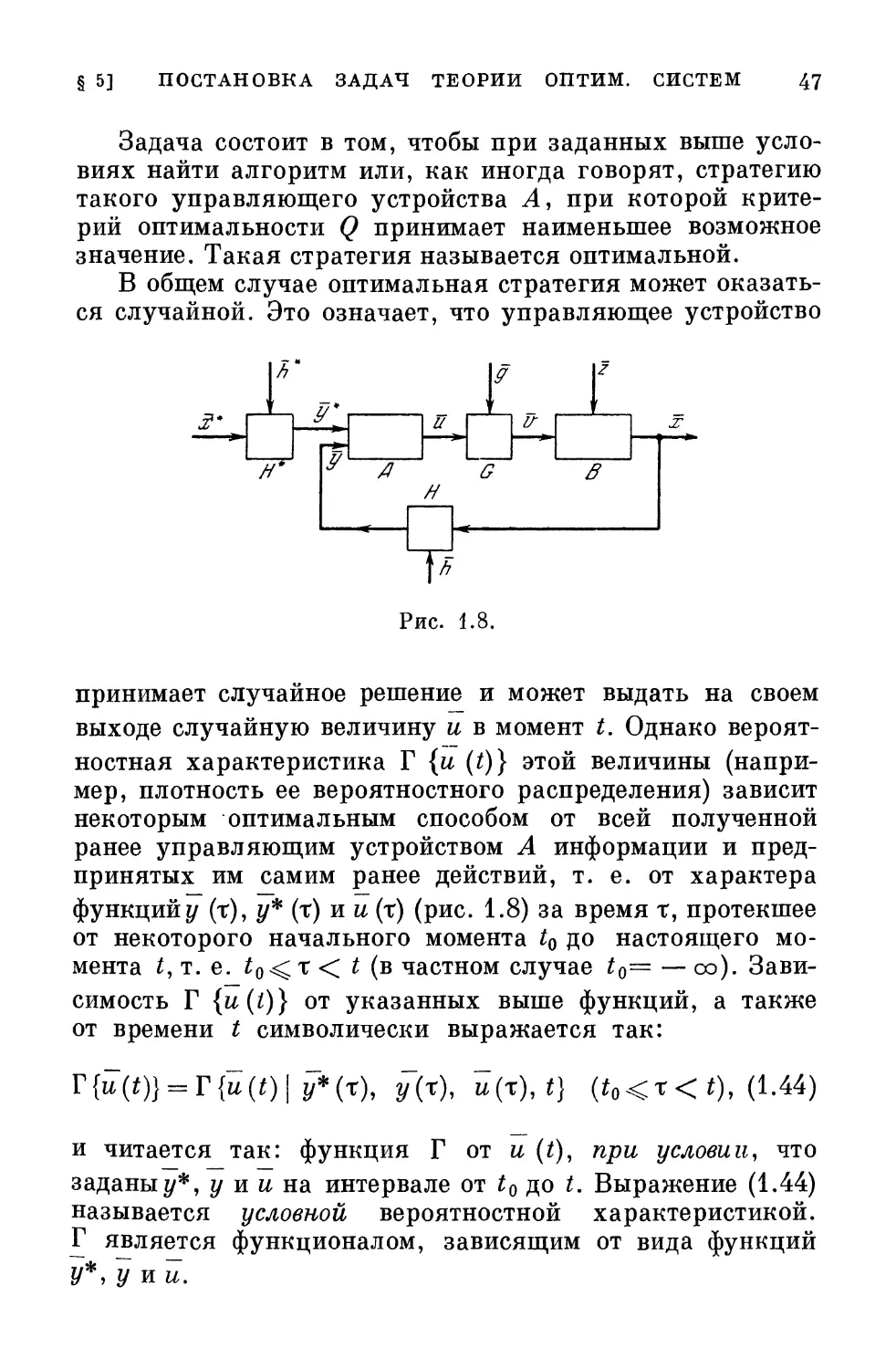

Структурная схема, рассматривавшаяся в [6.1, 6.2],

показана на рис. 1.8. Управляющее воздействие

^поступает на объект В через канал связи G, где оно

смешивается с случайной помехой (шумом) g. Поэтому

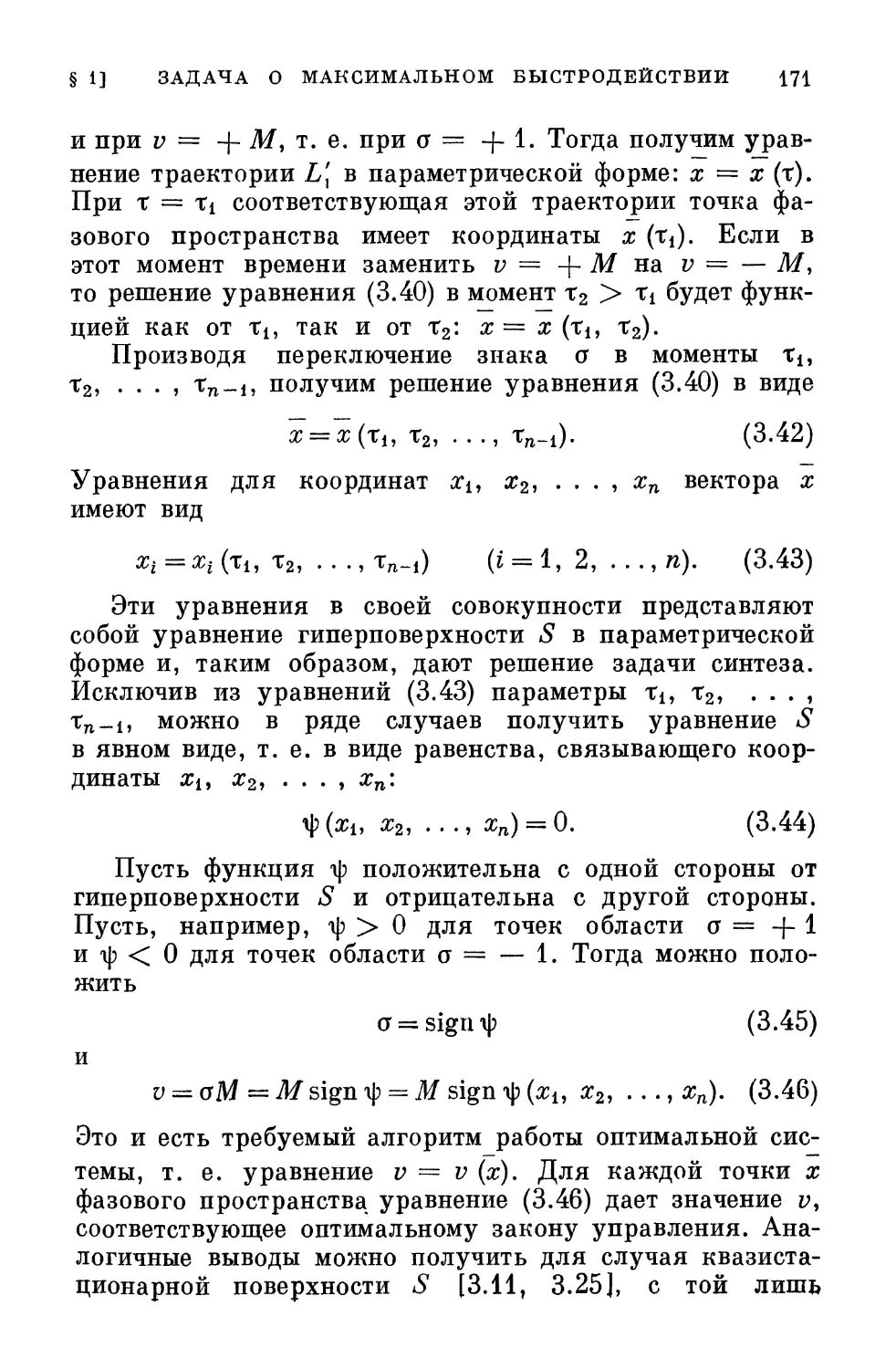

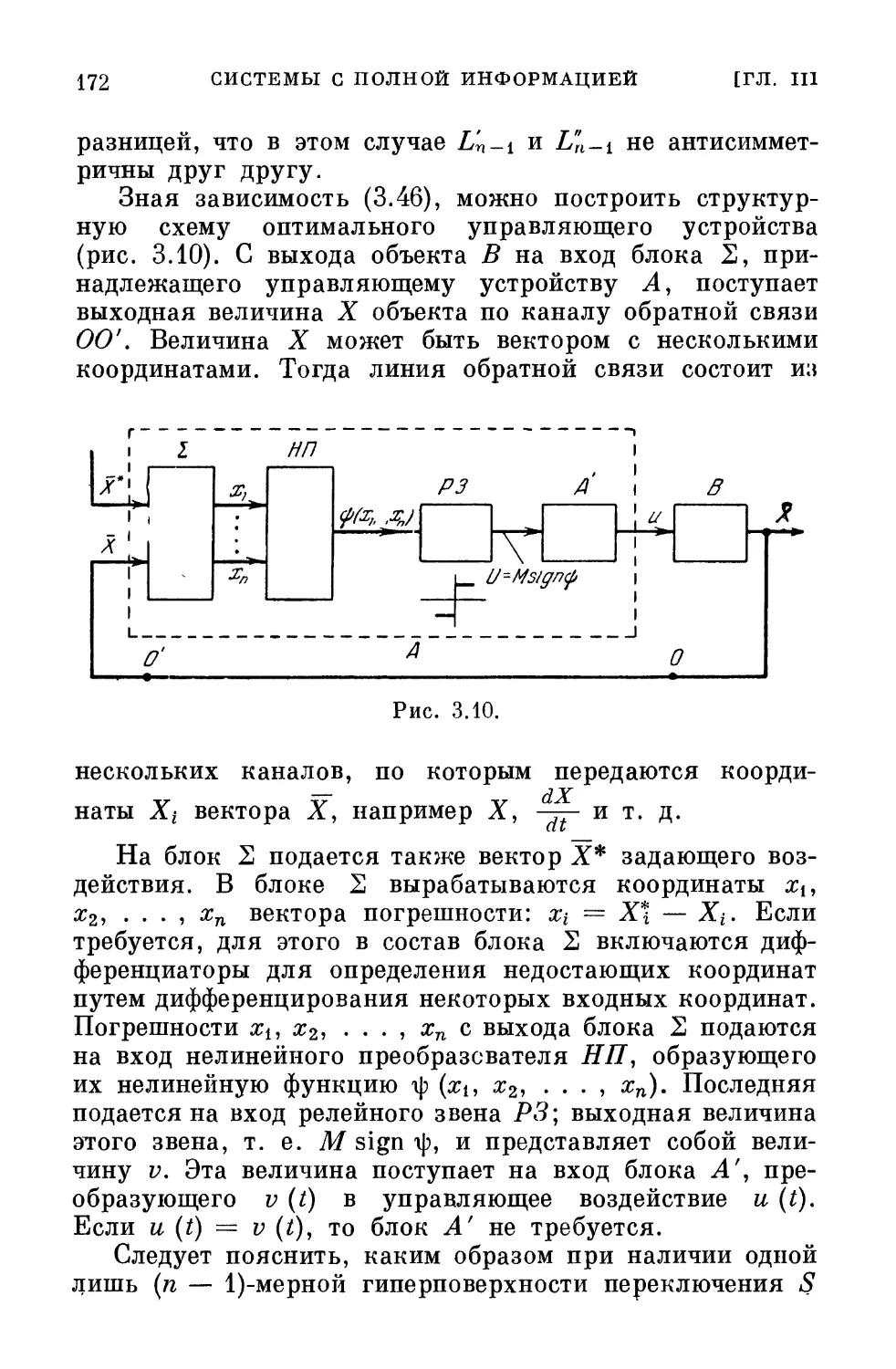

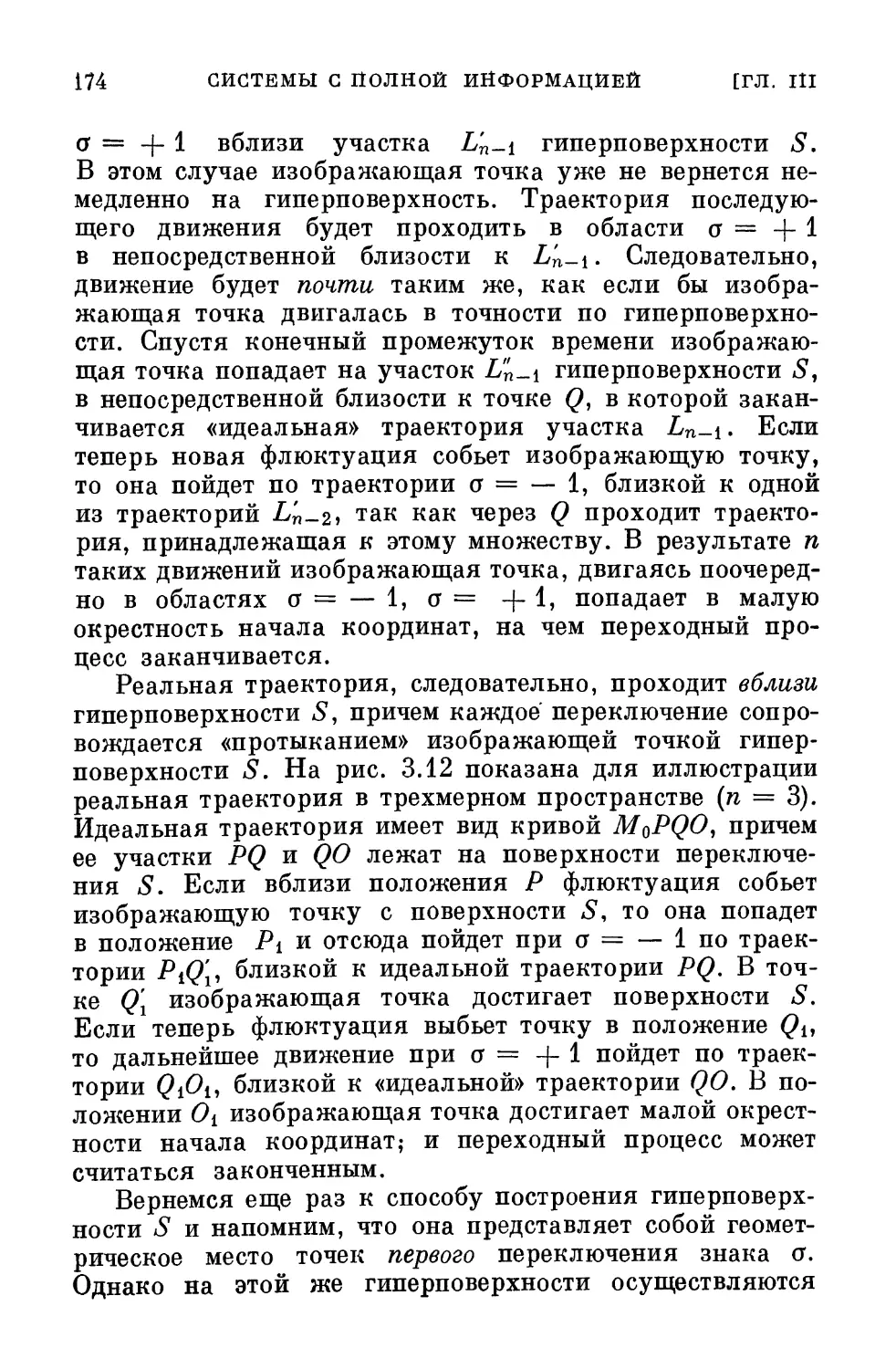

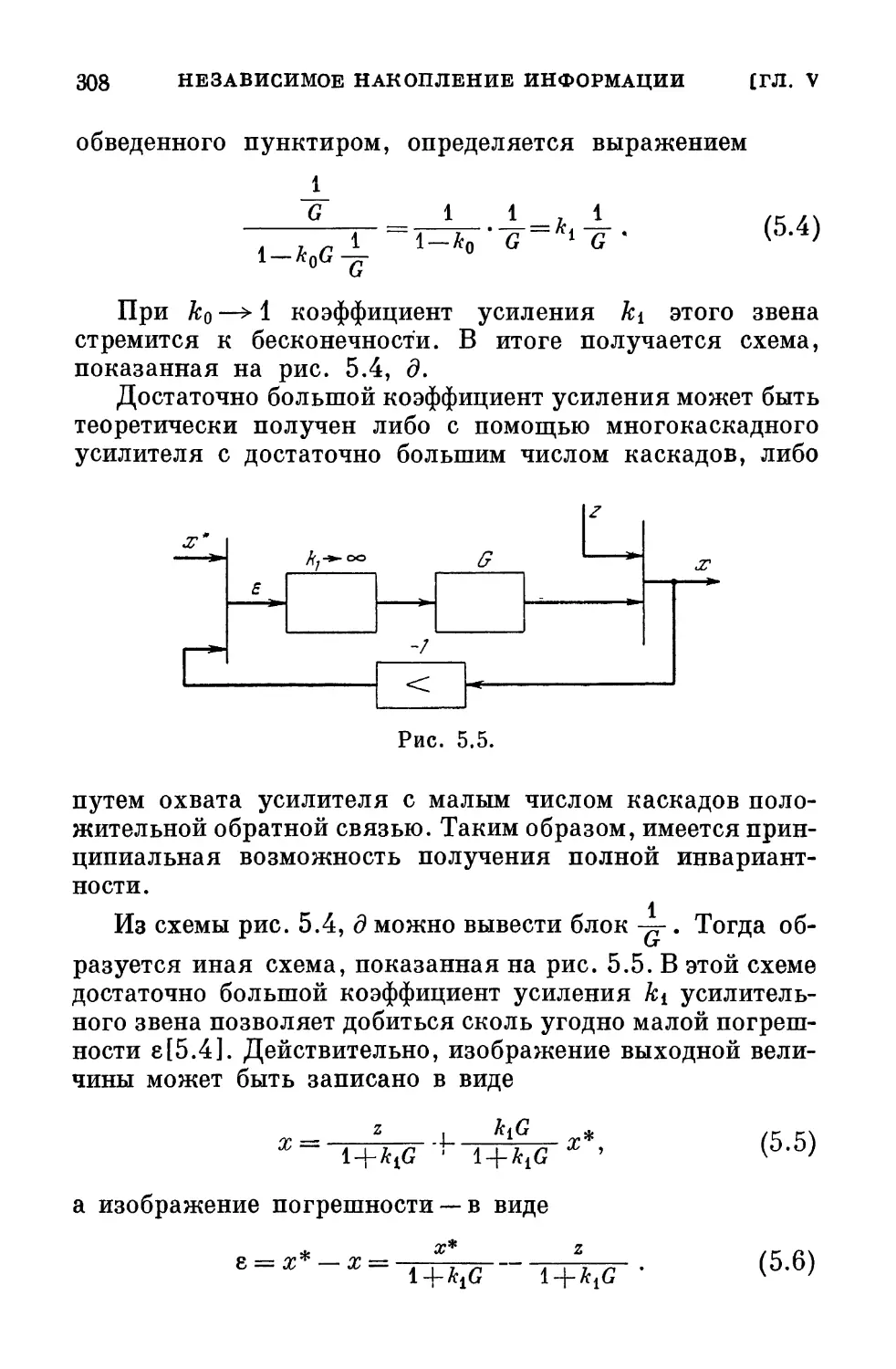

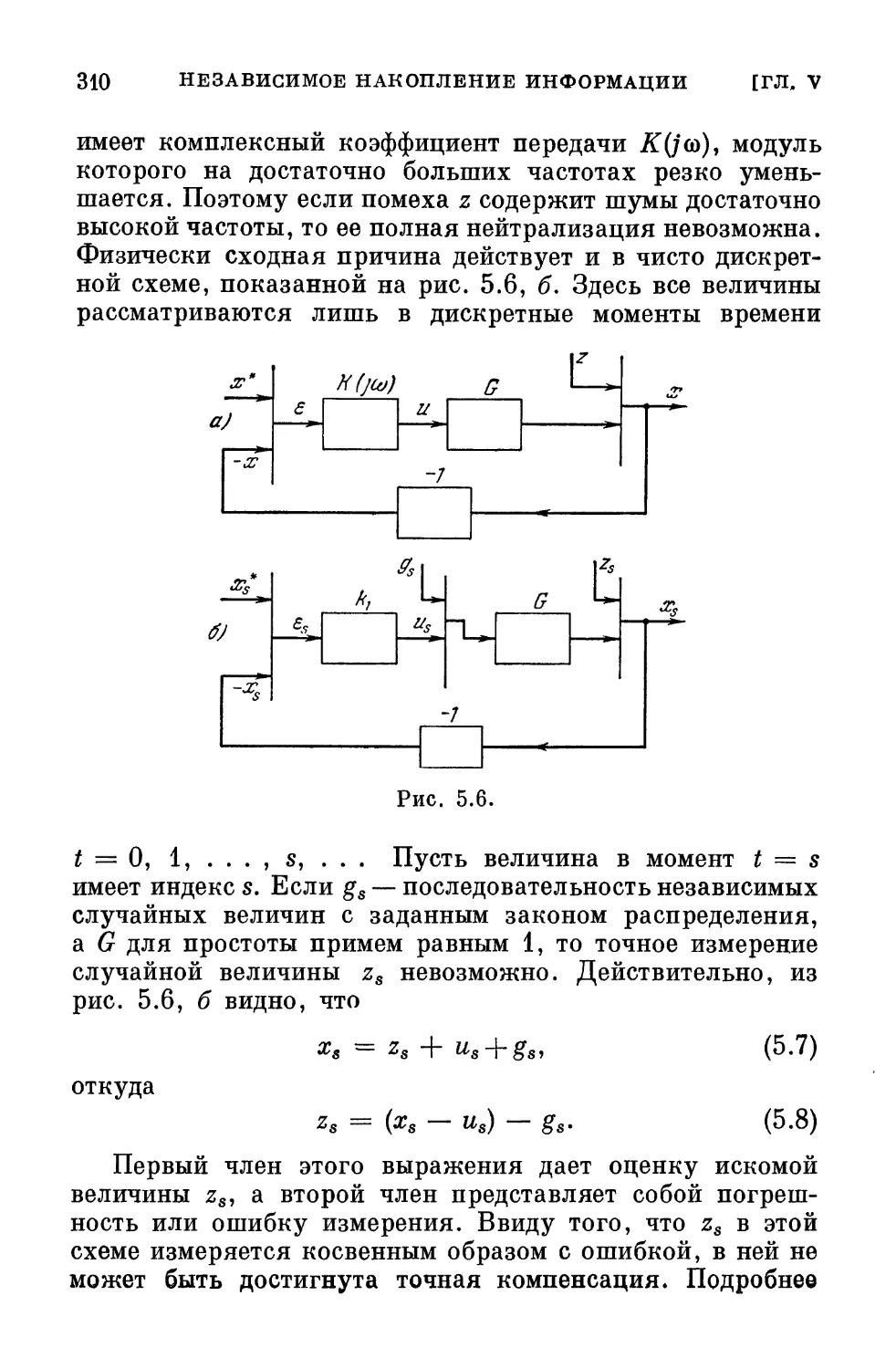

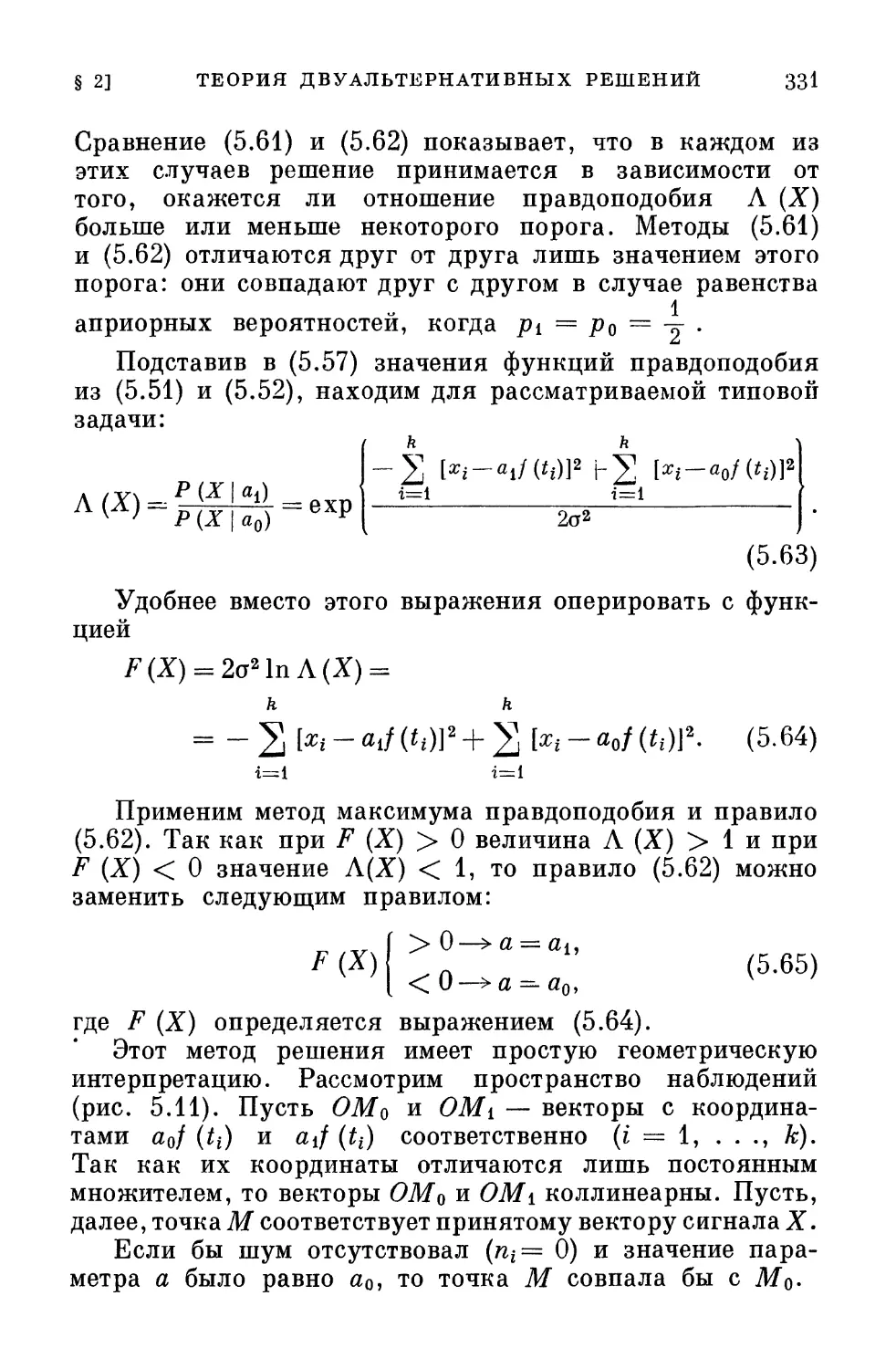

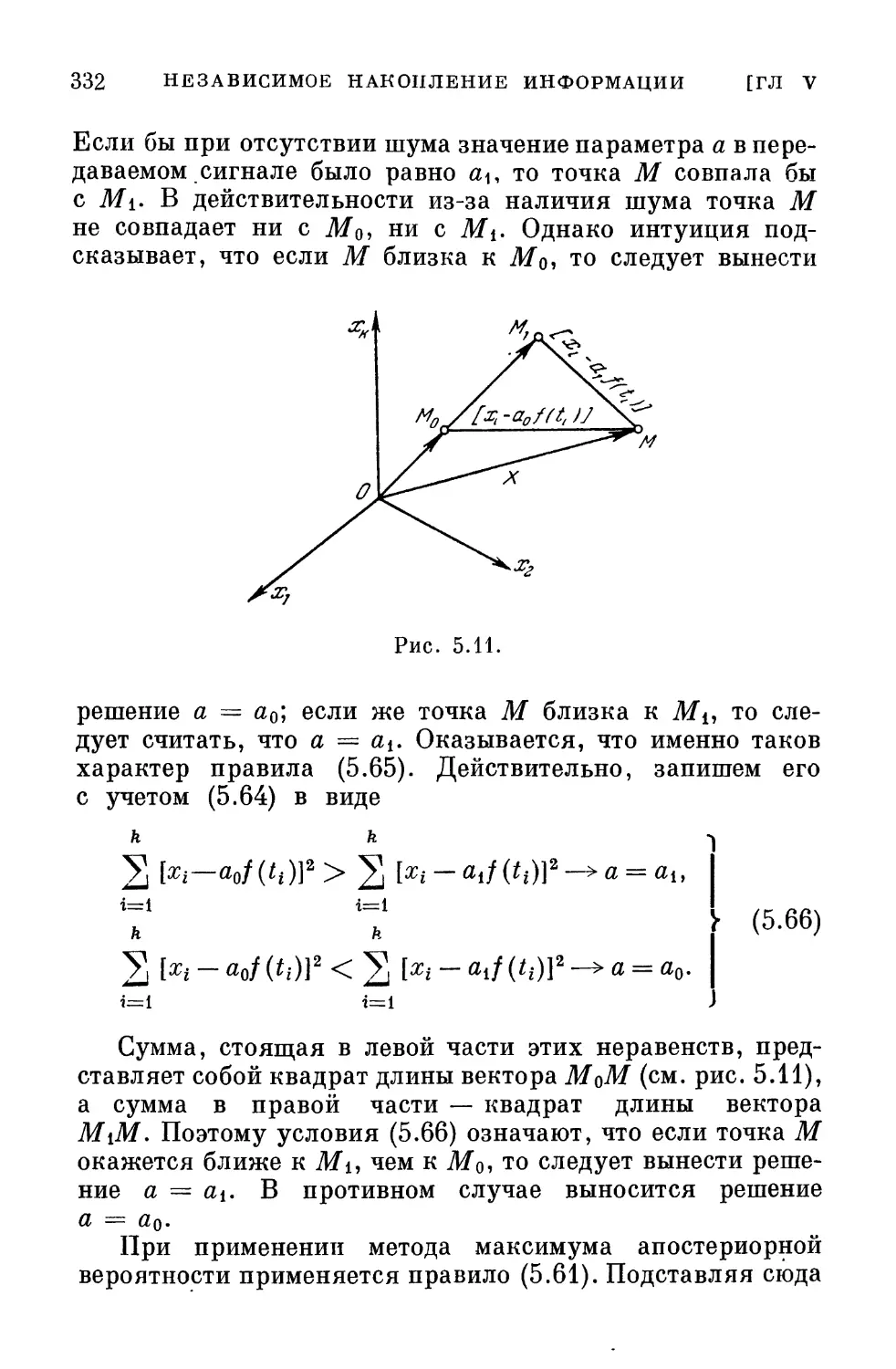

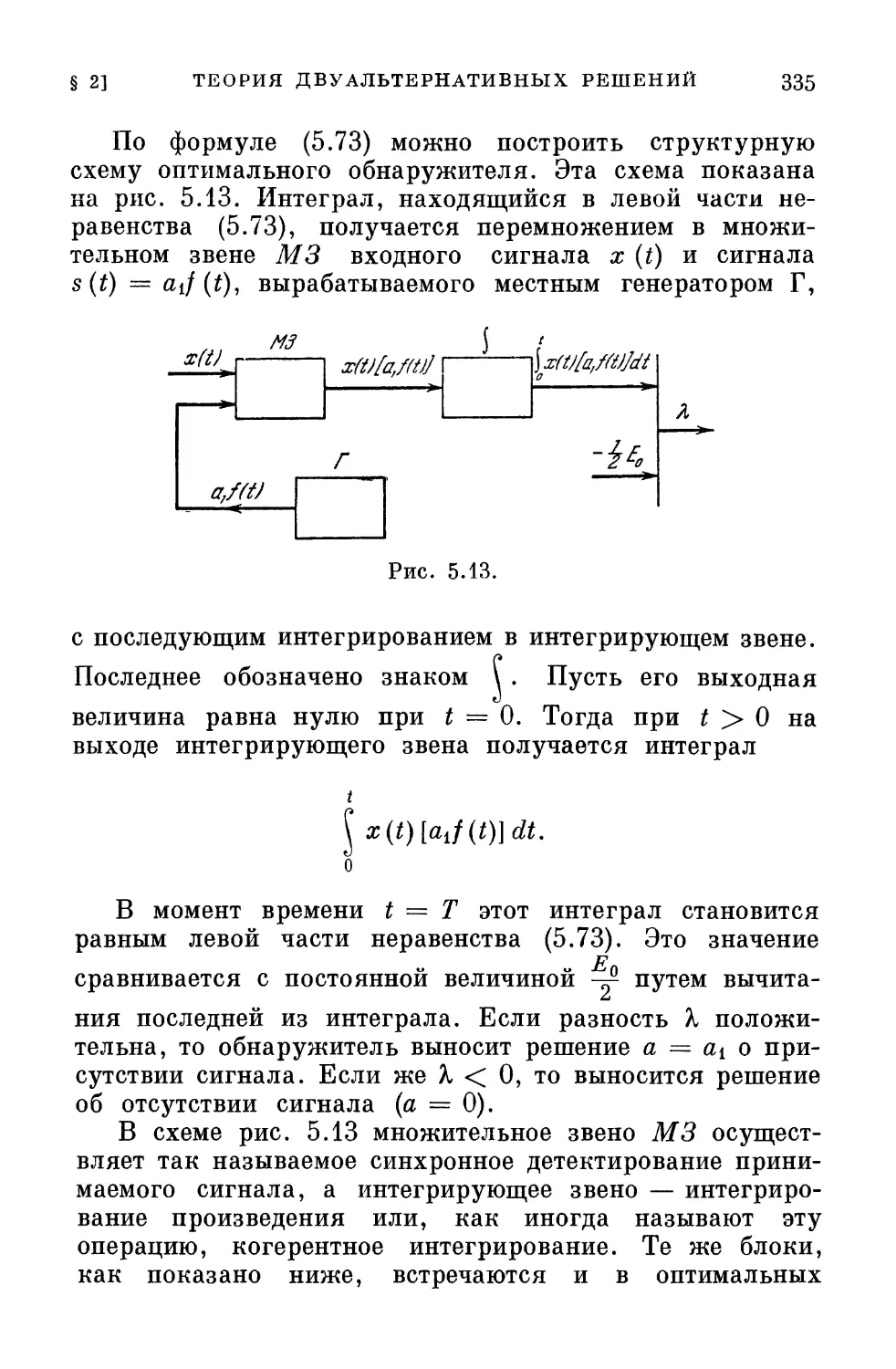

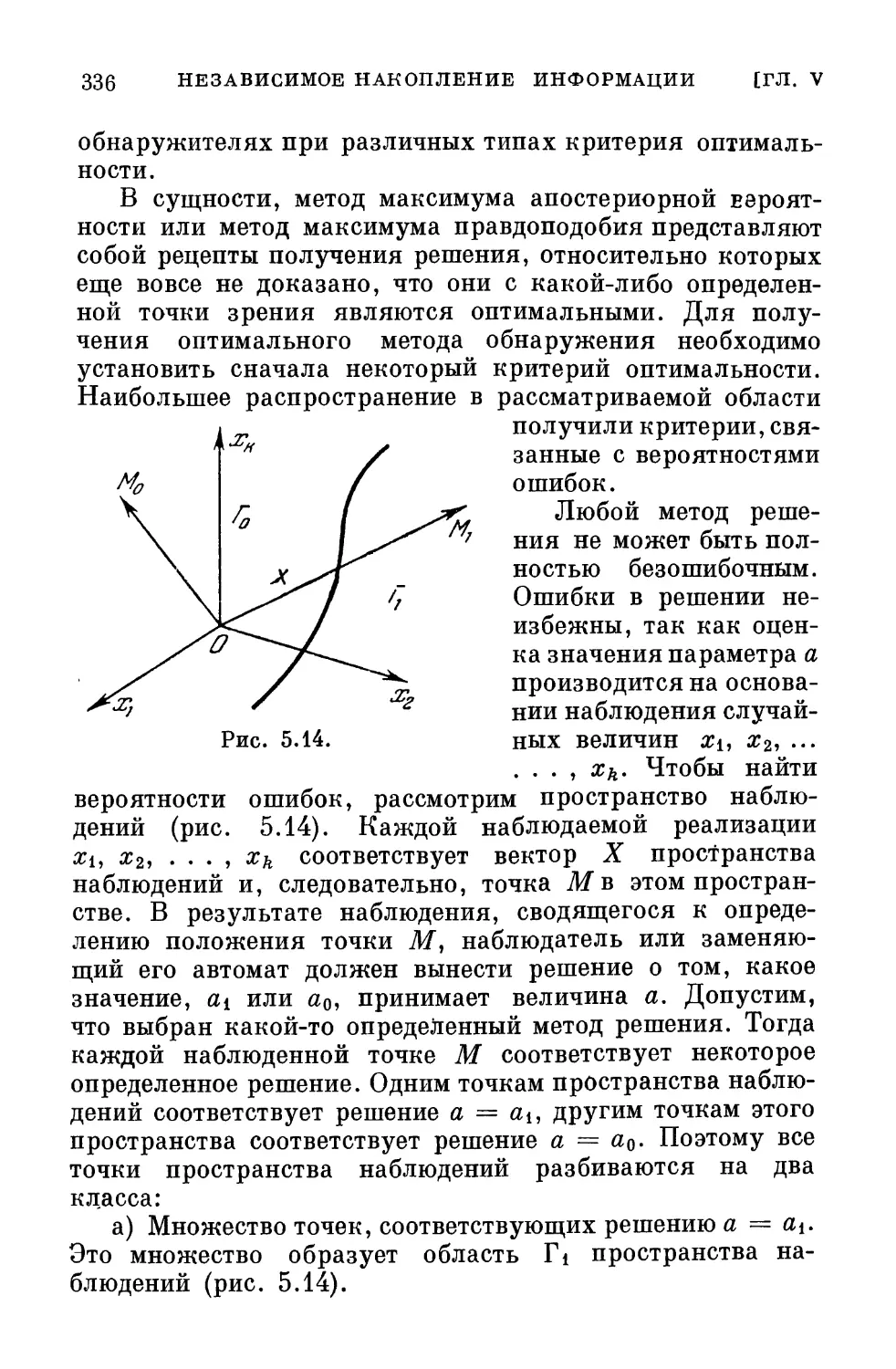

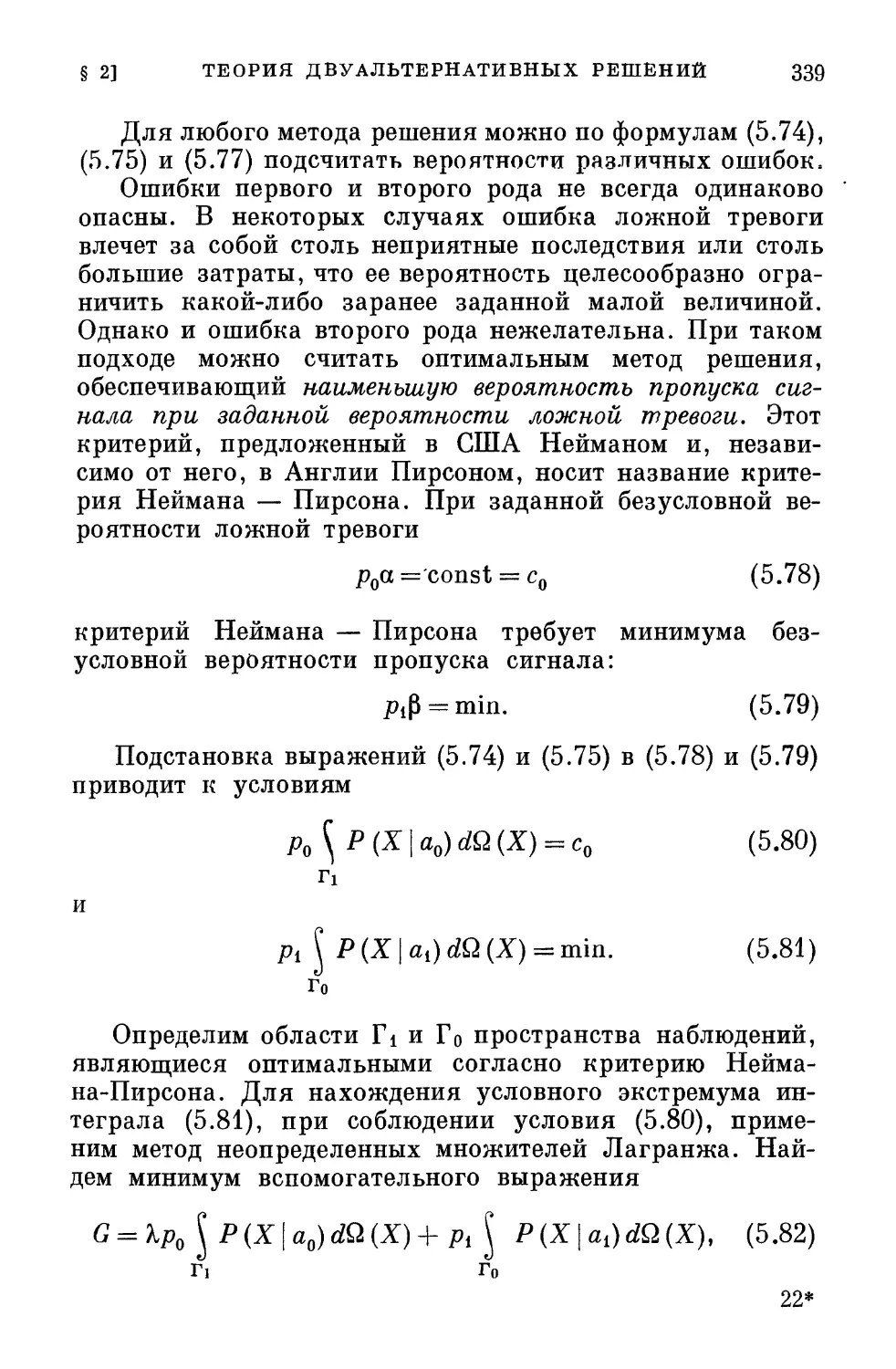

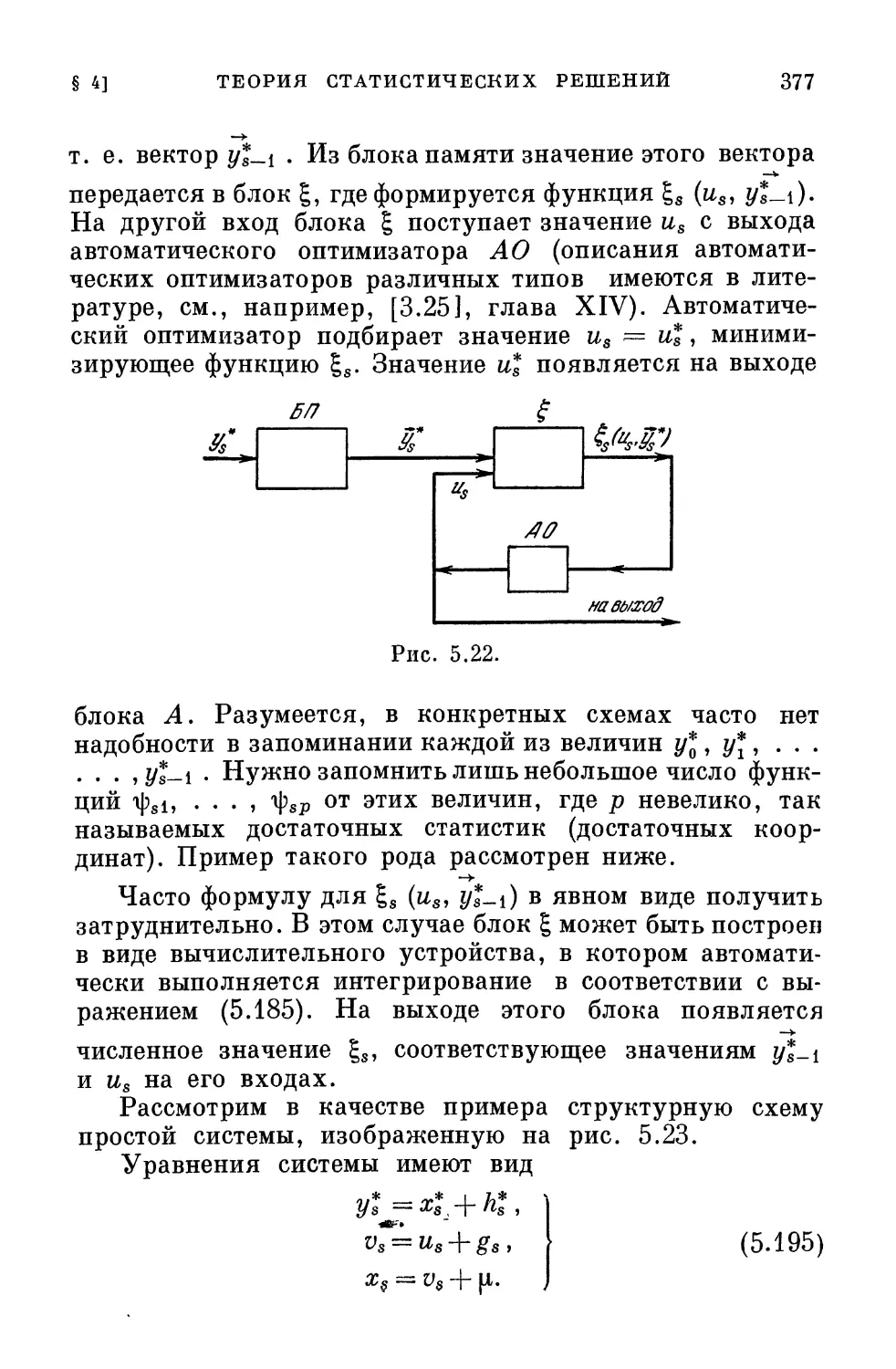

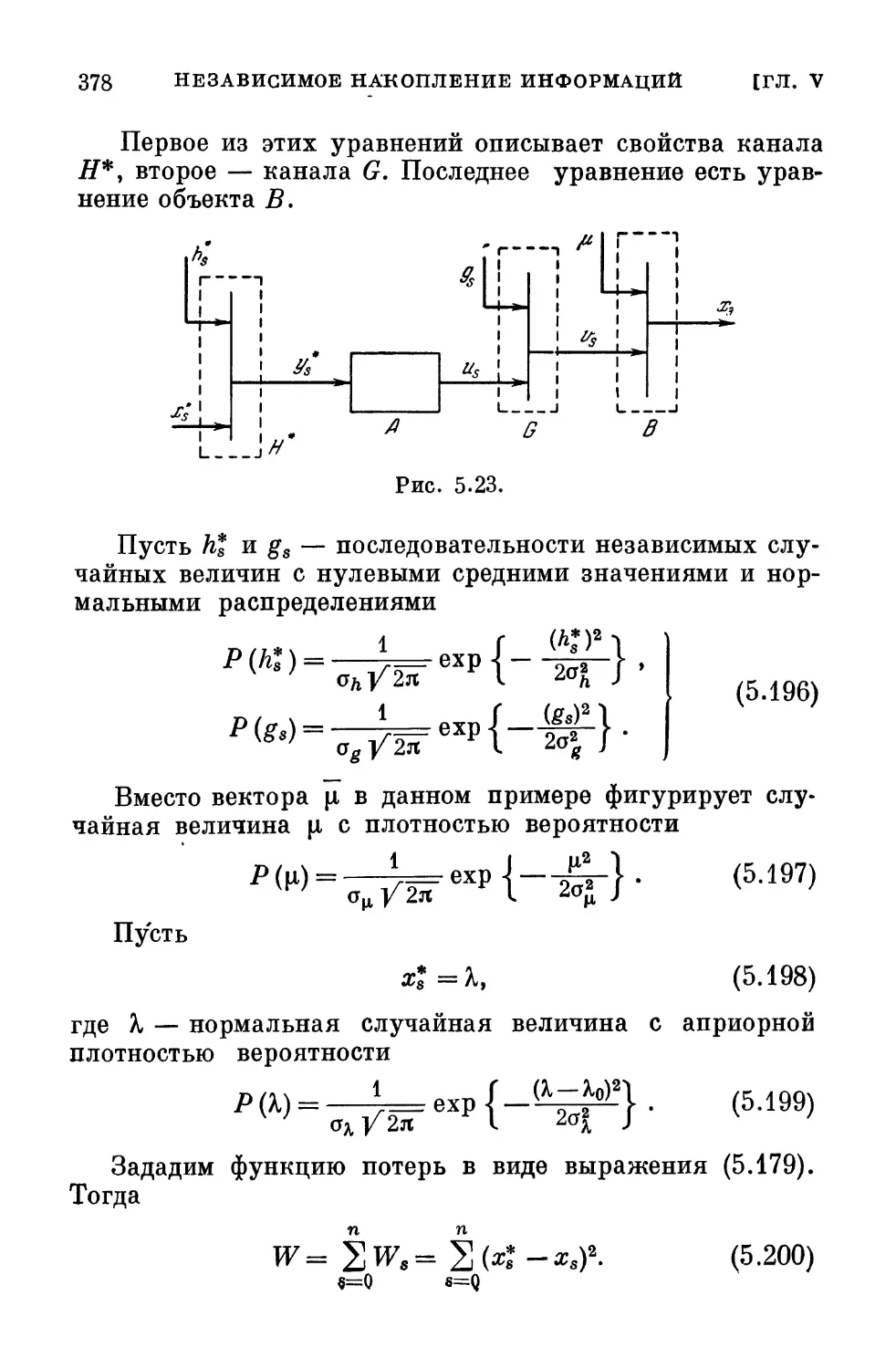

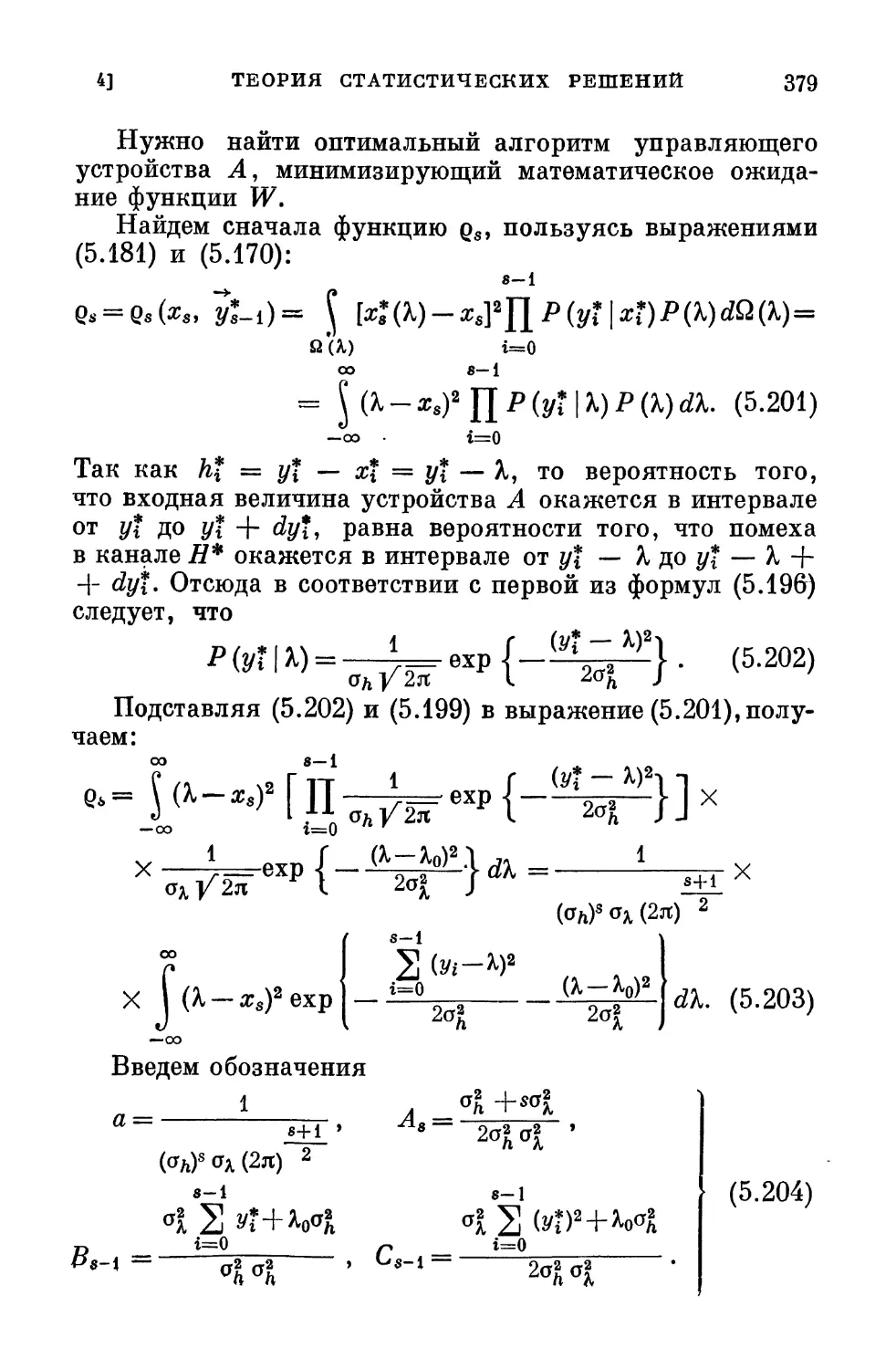

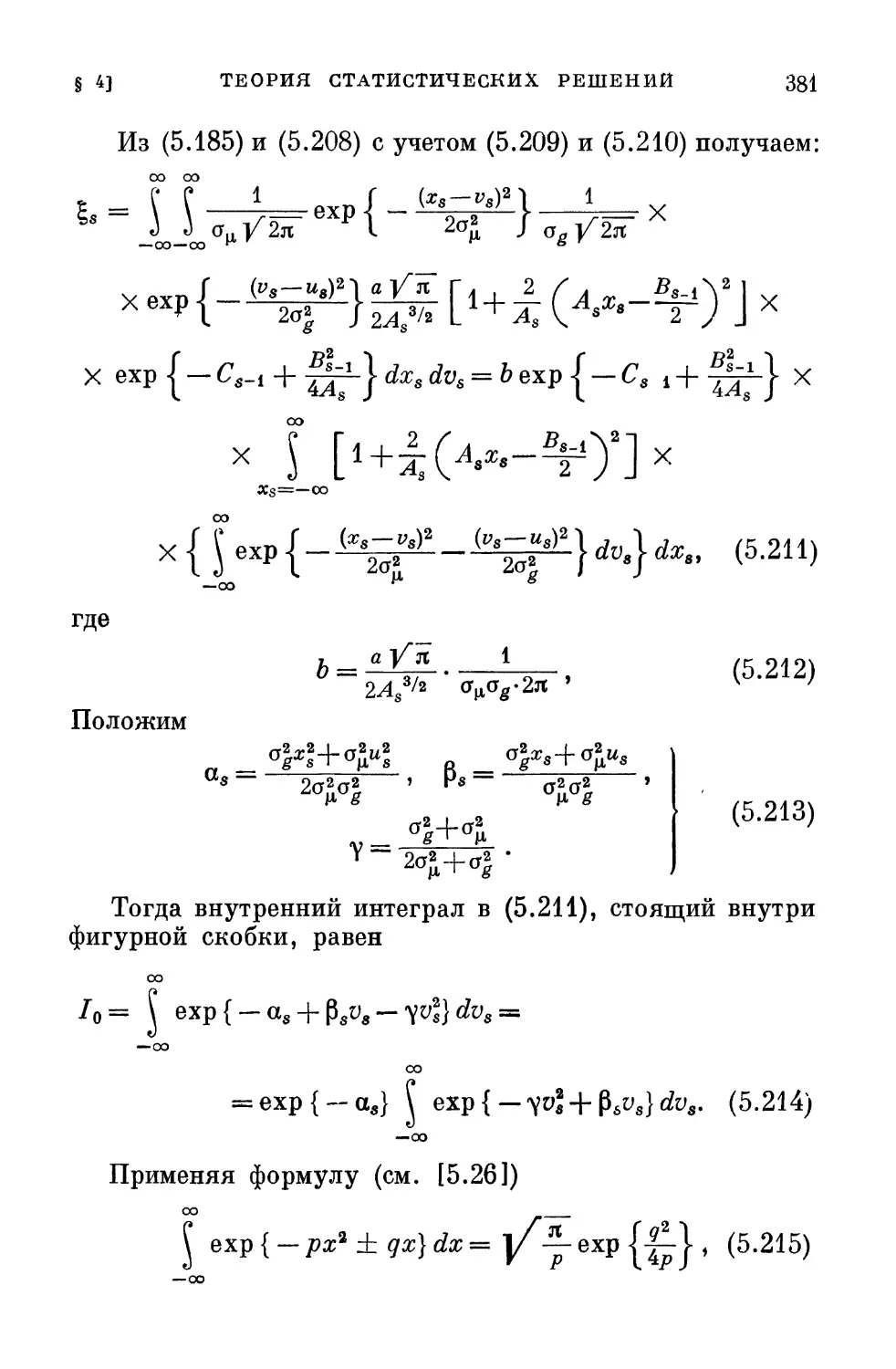

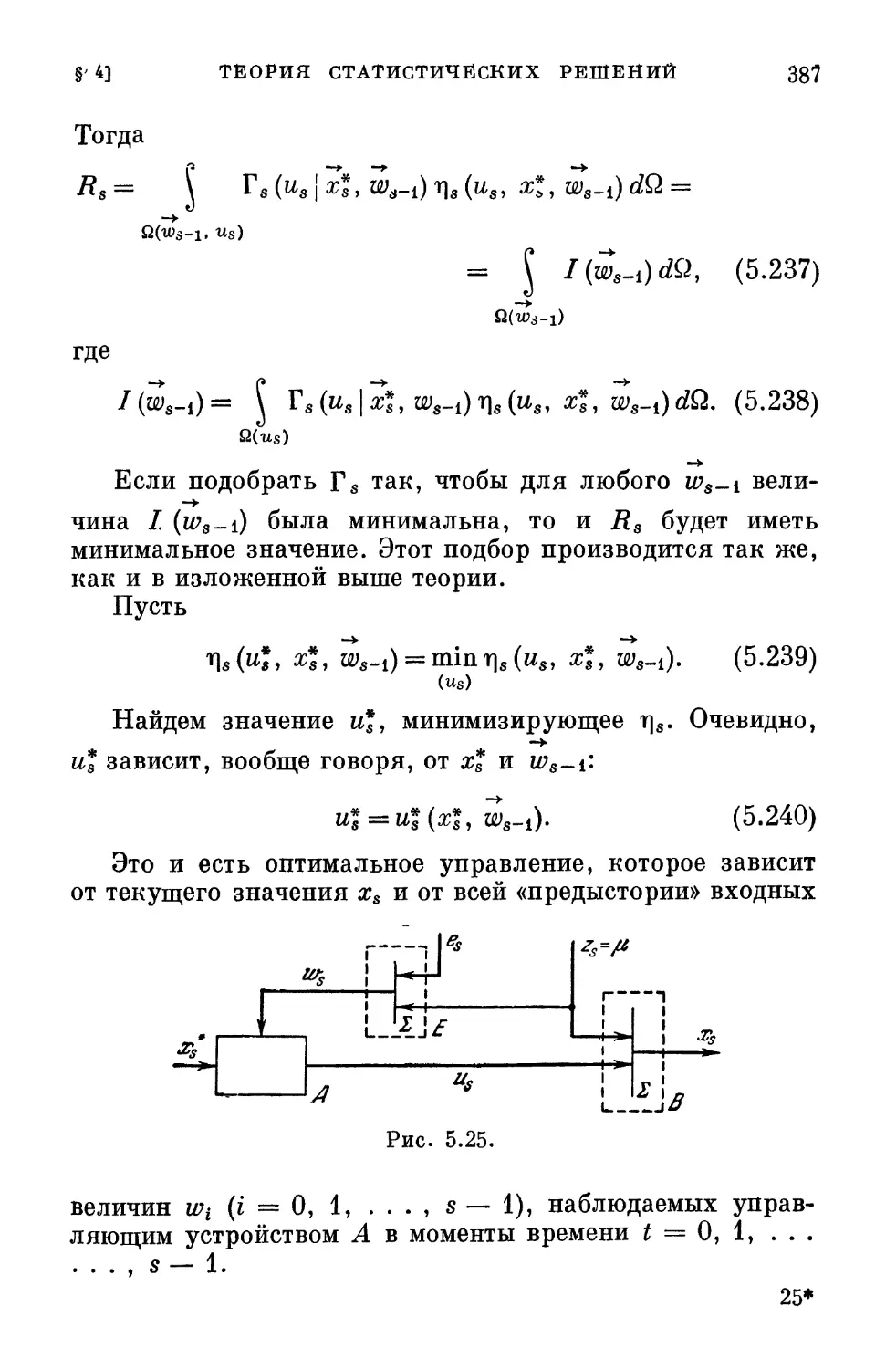

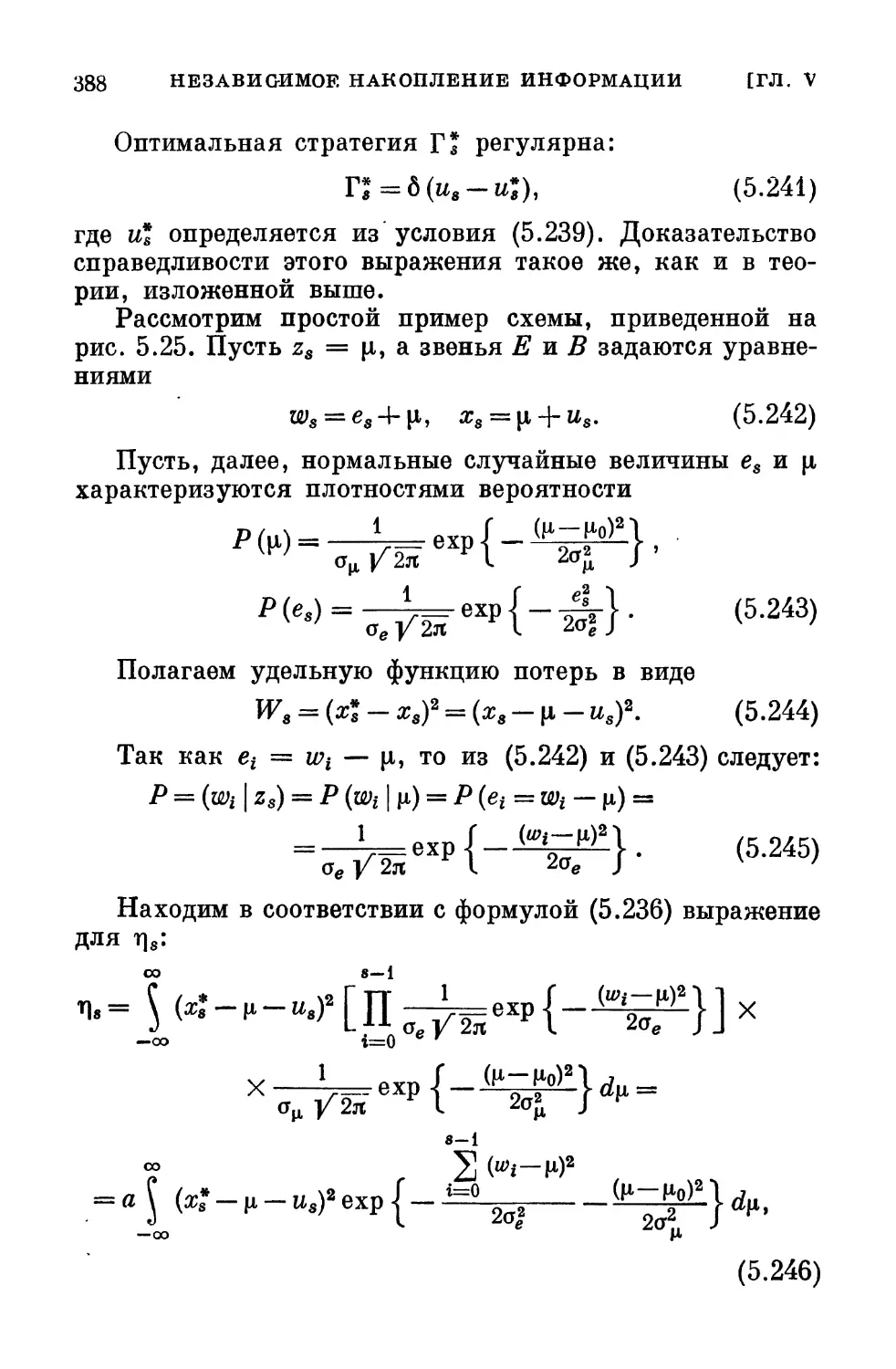

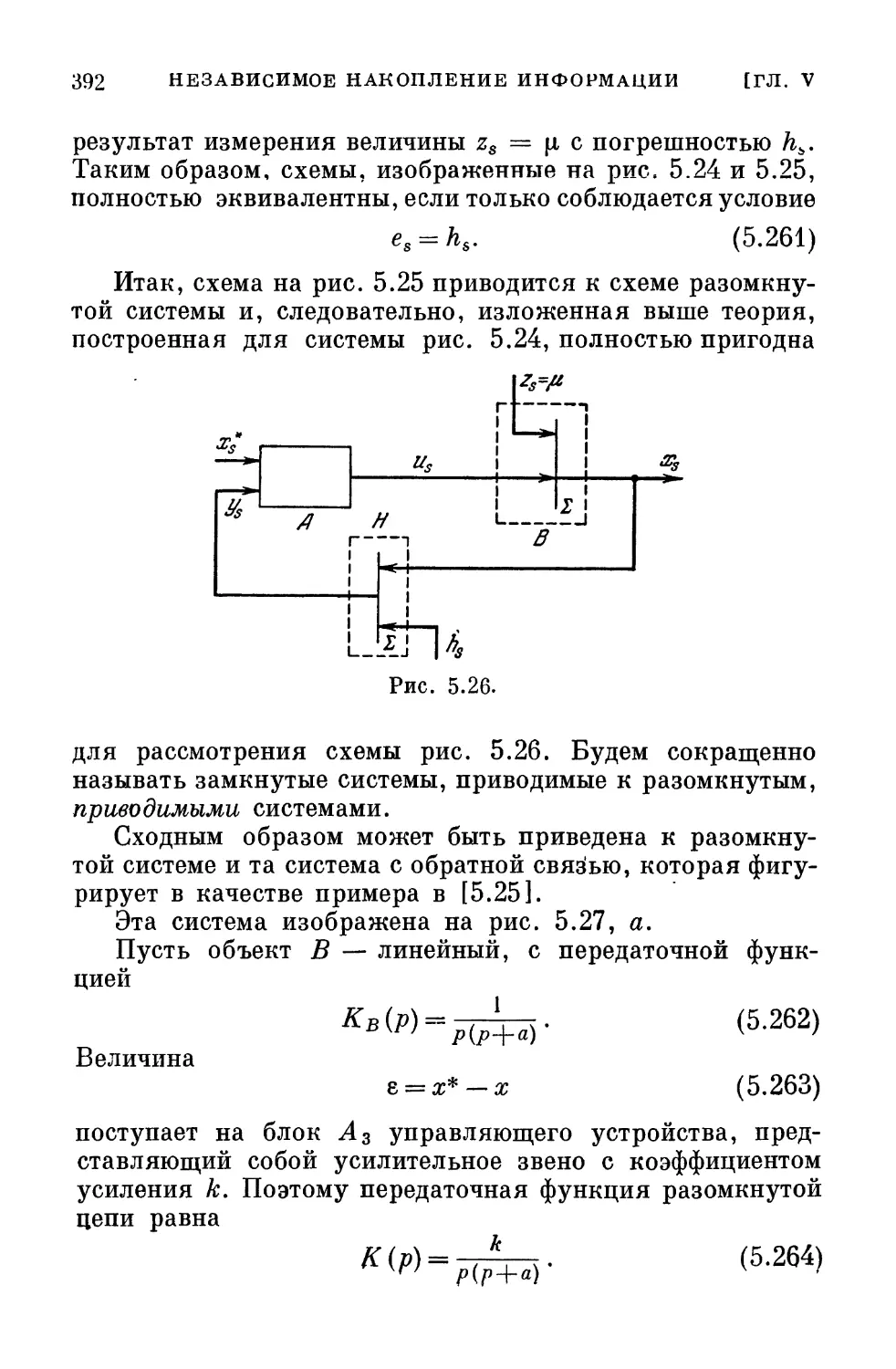

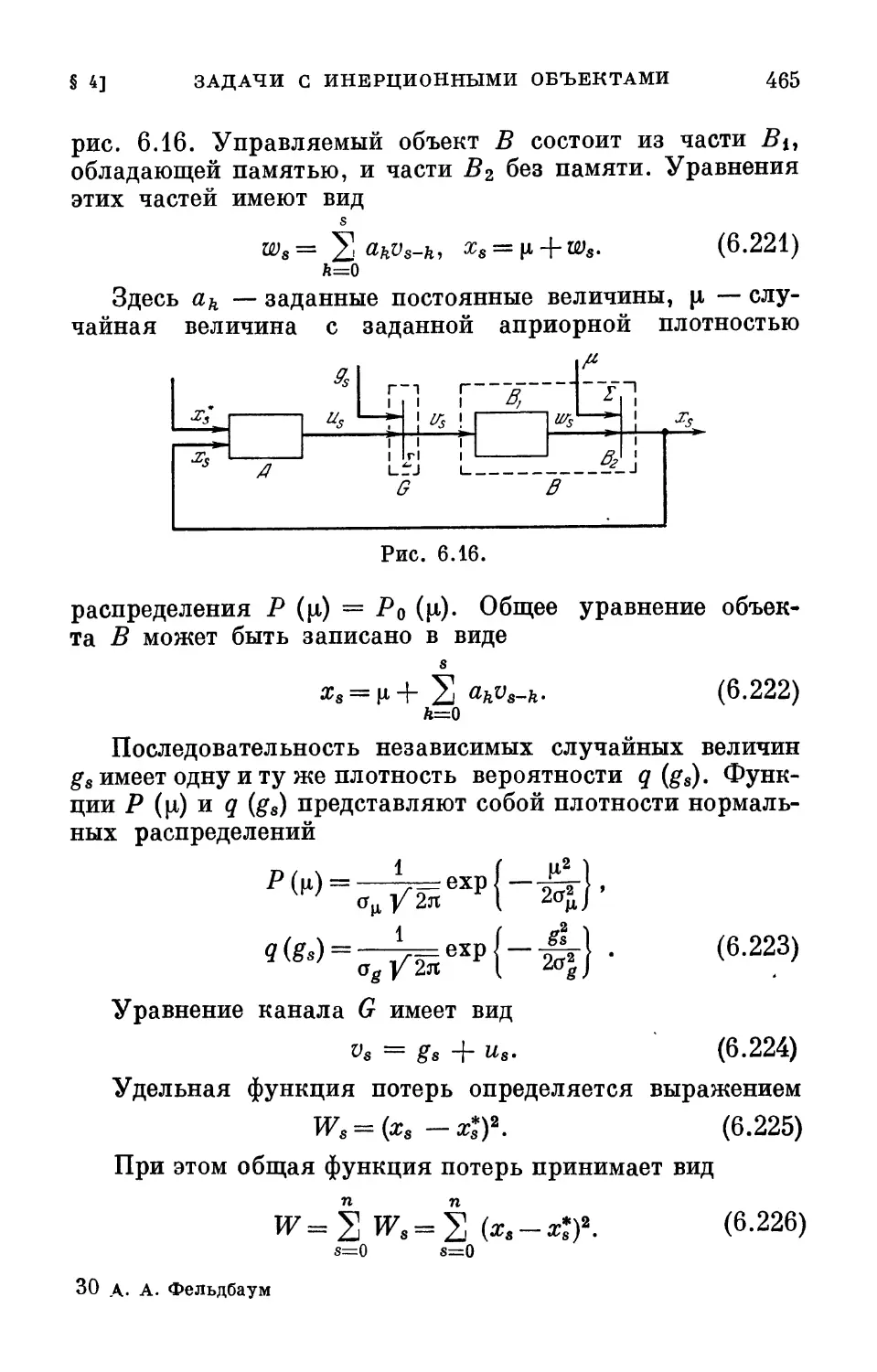

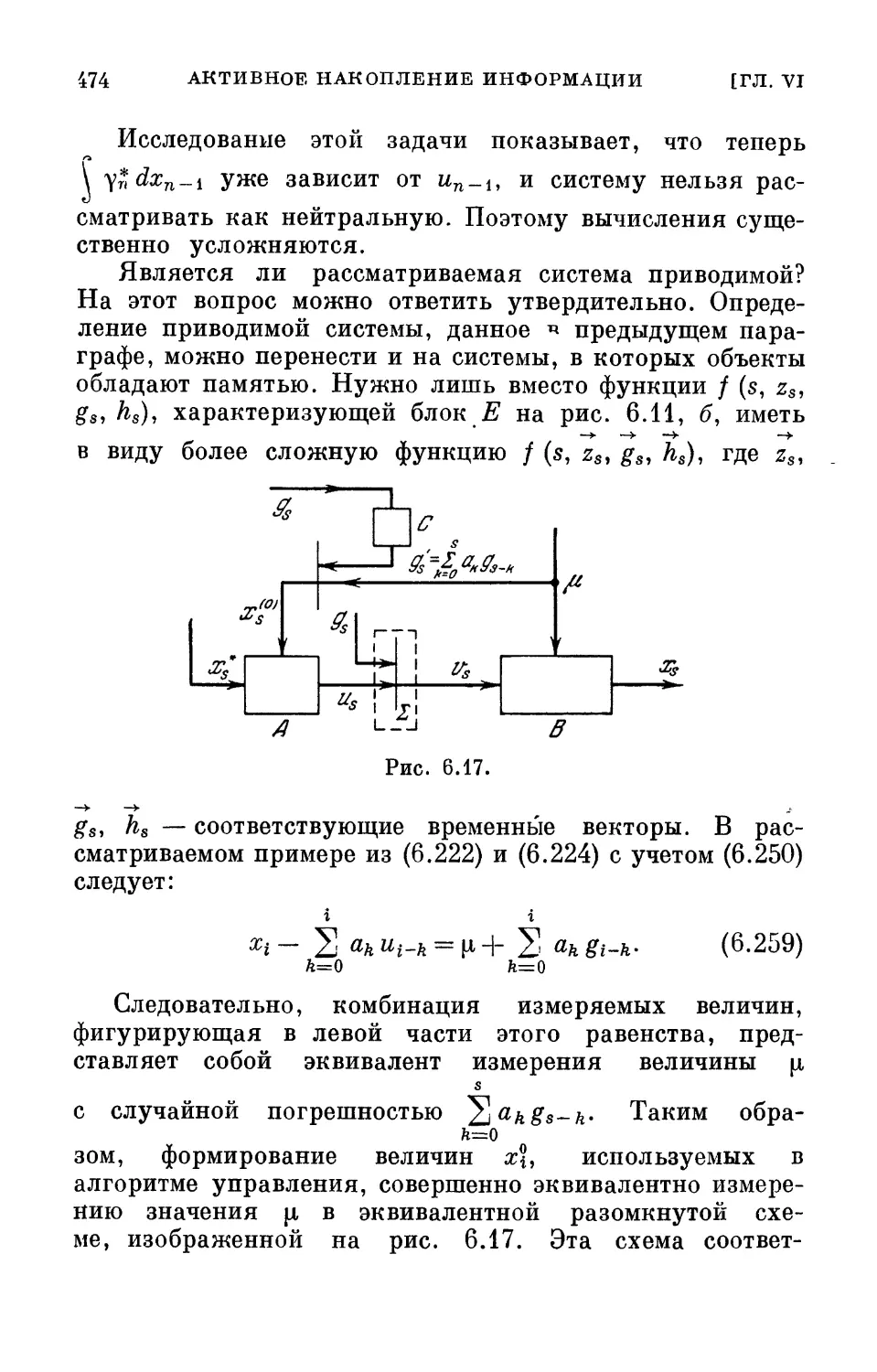

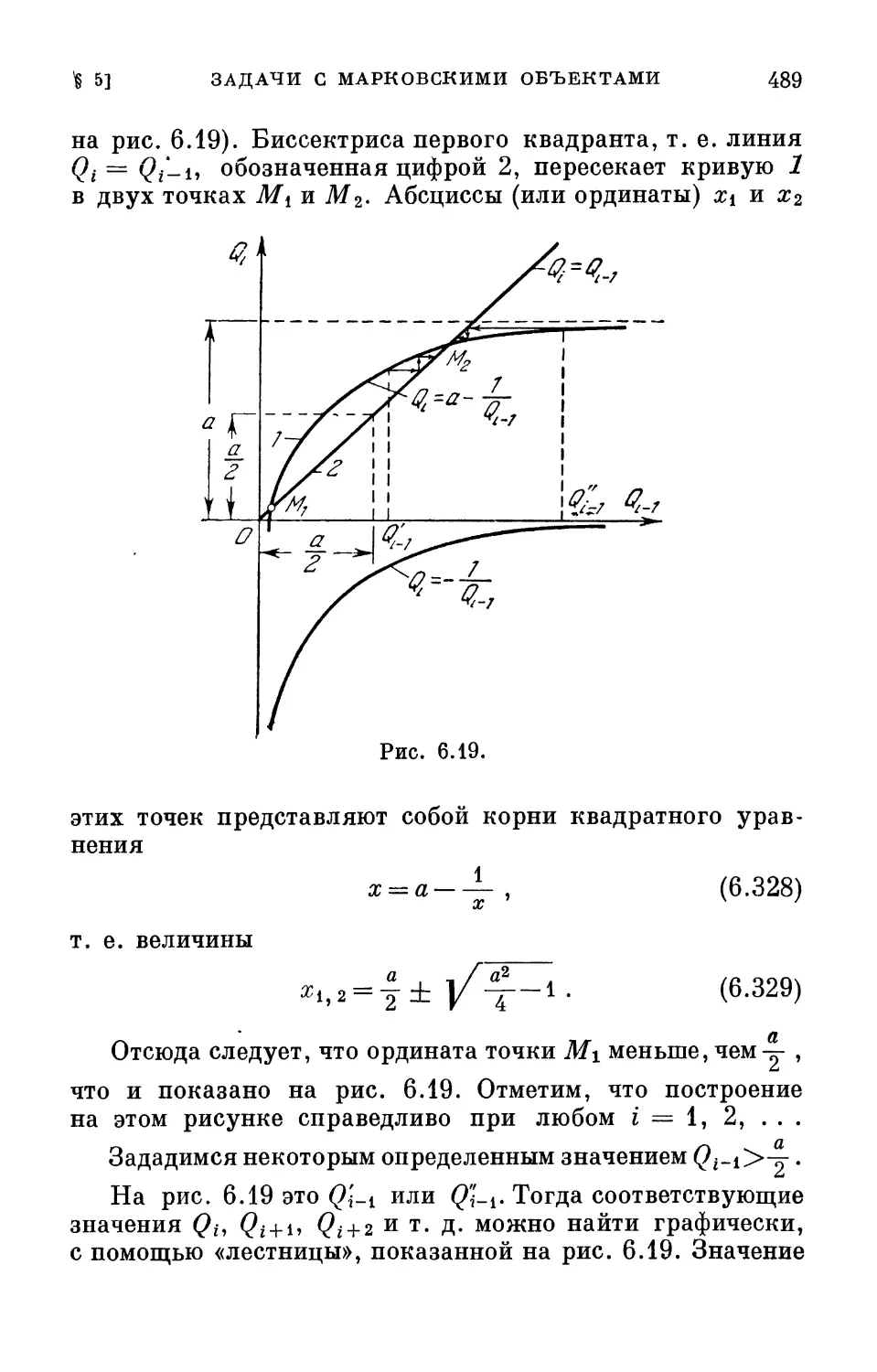

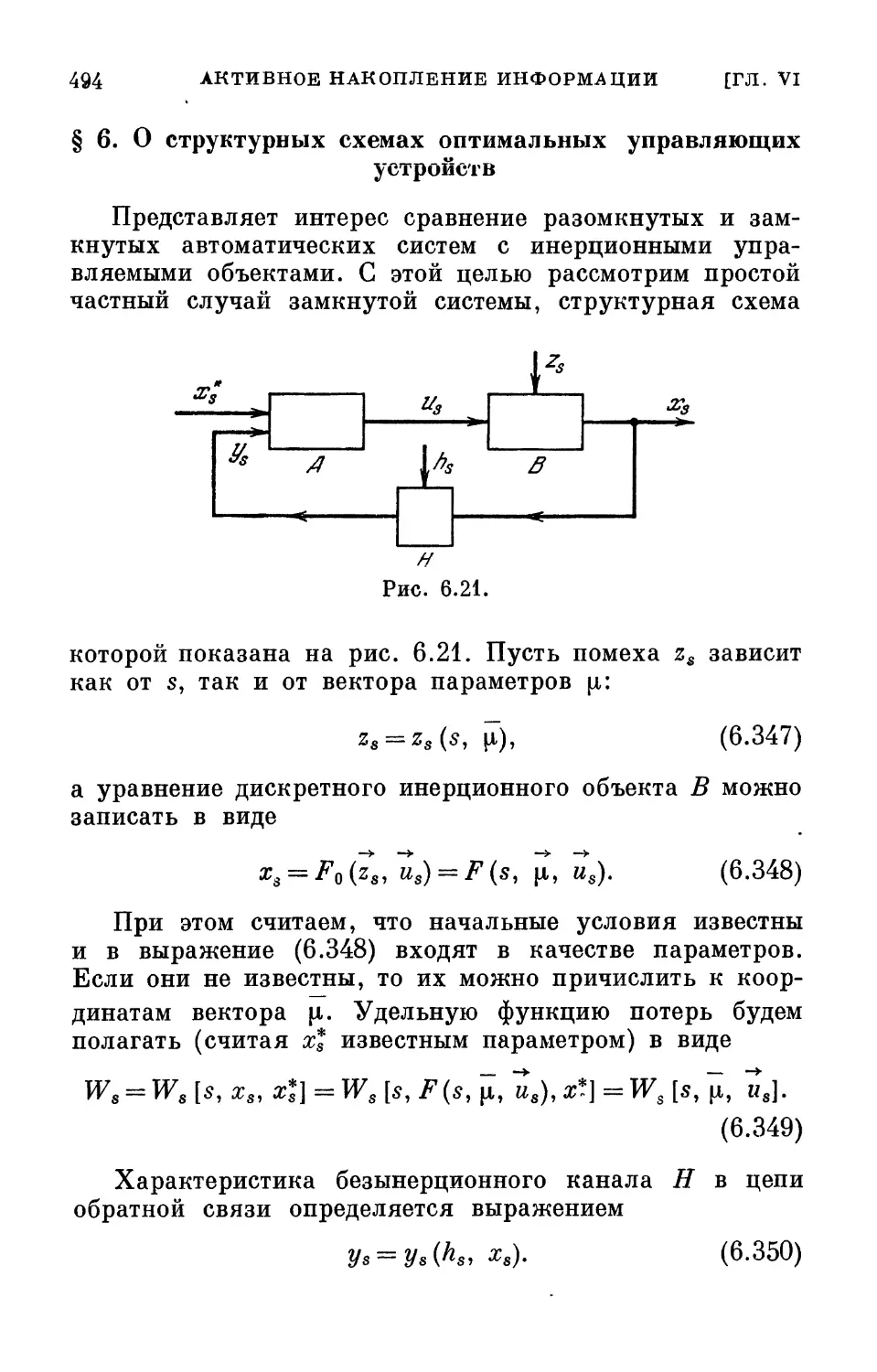

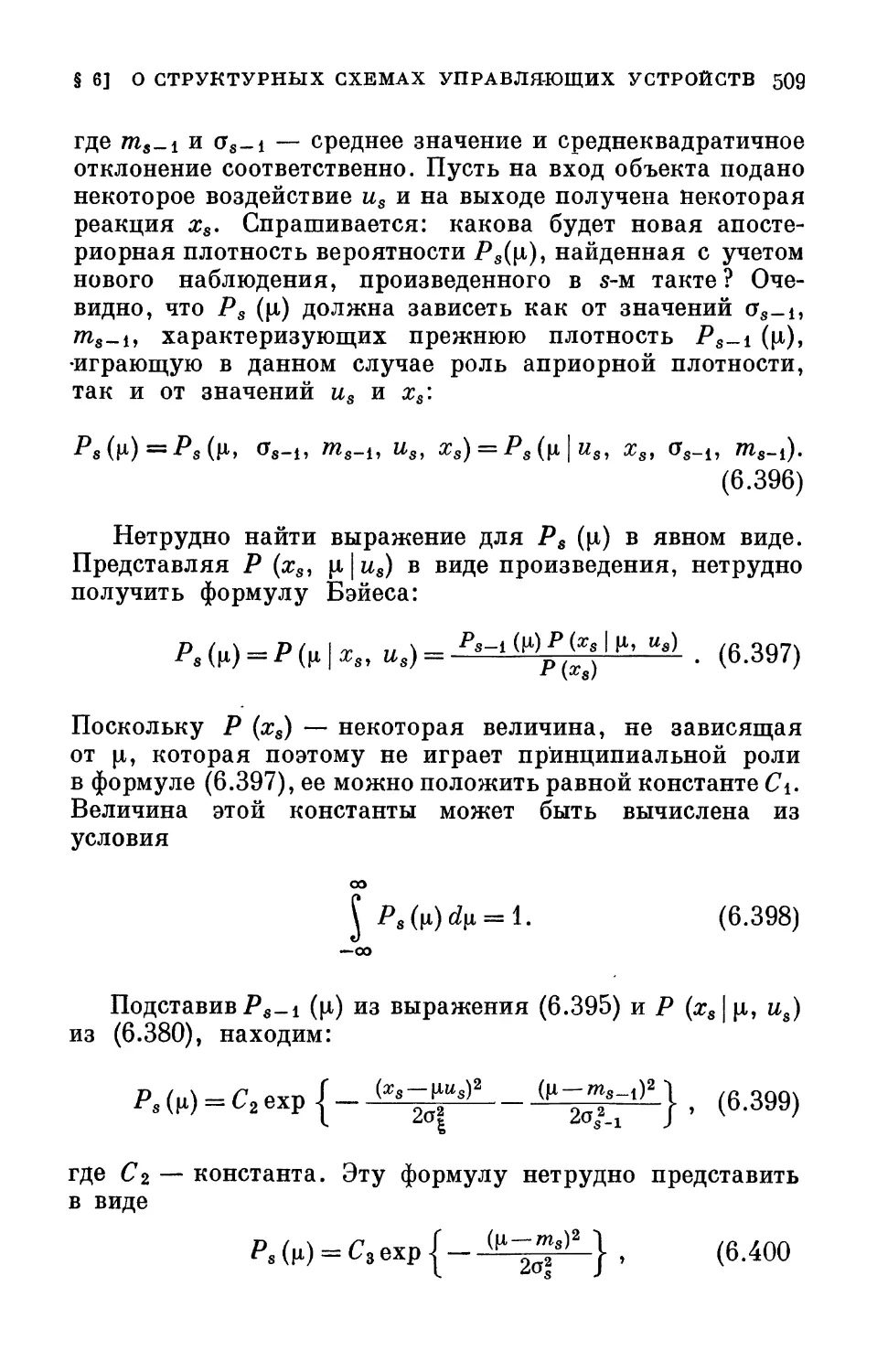

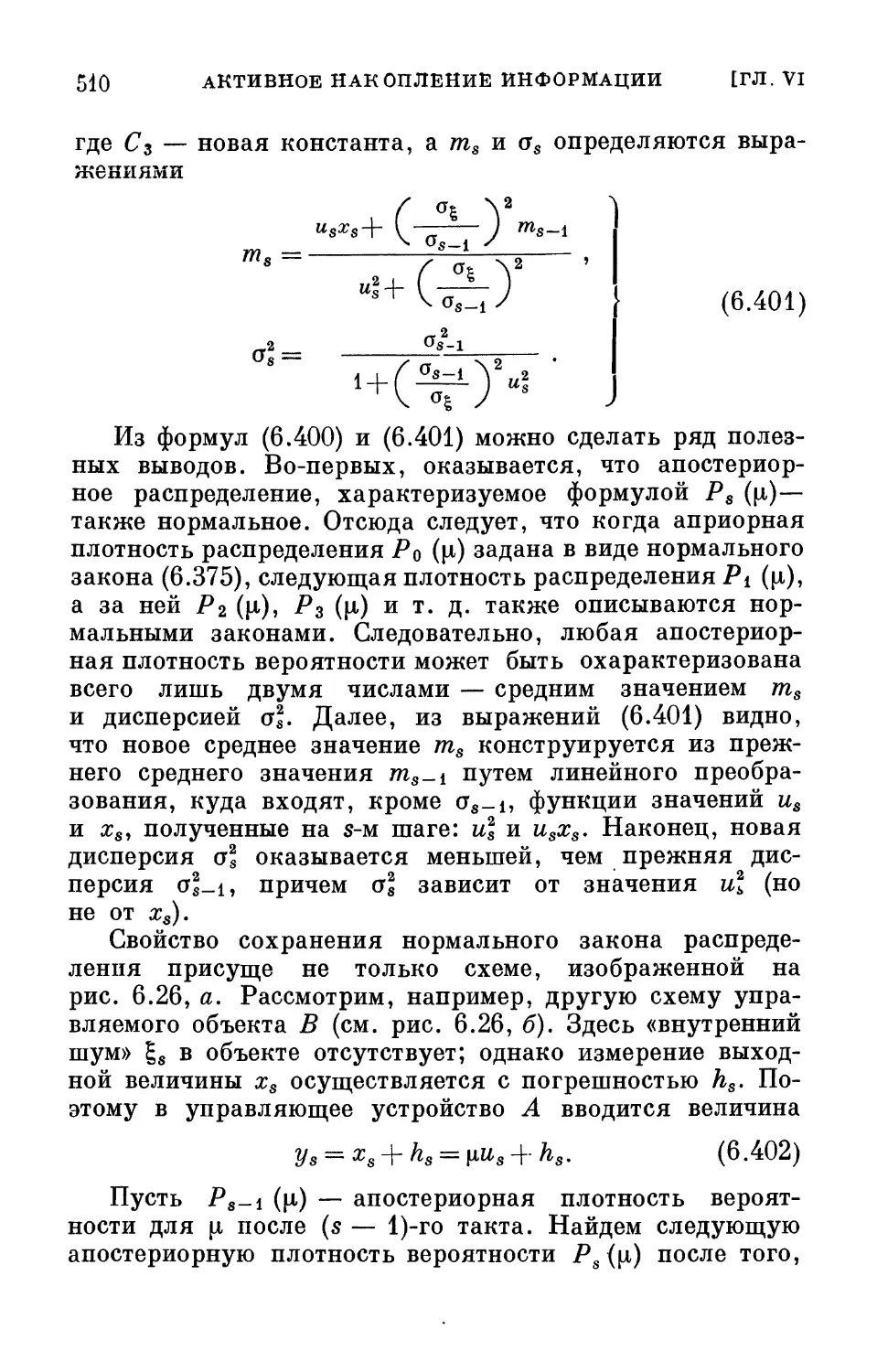

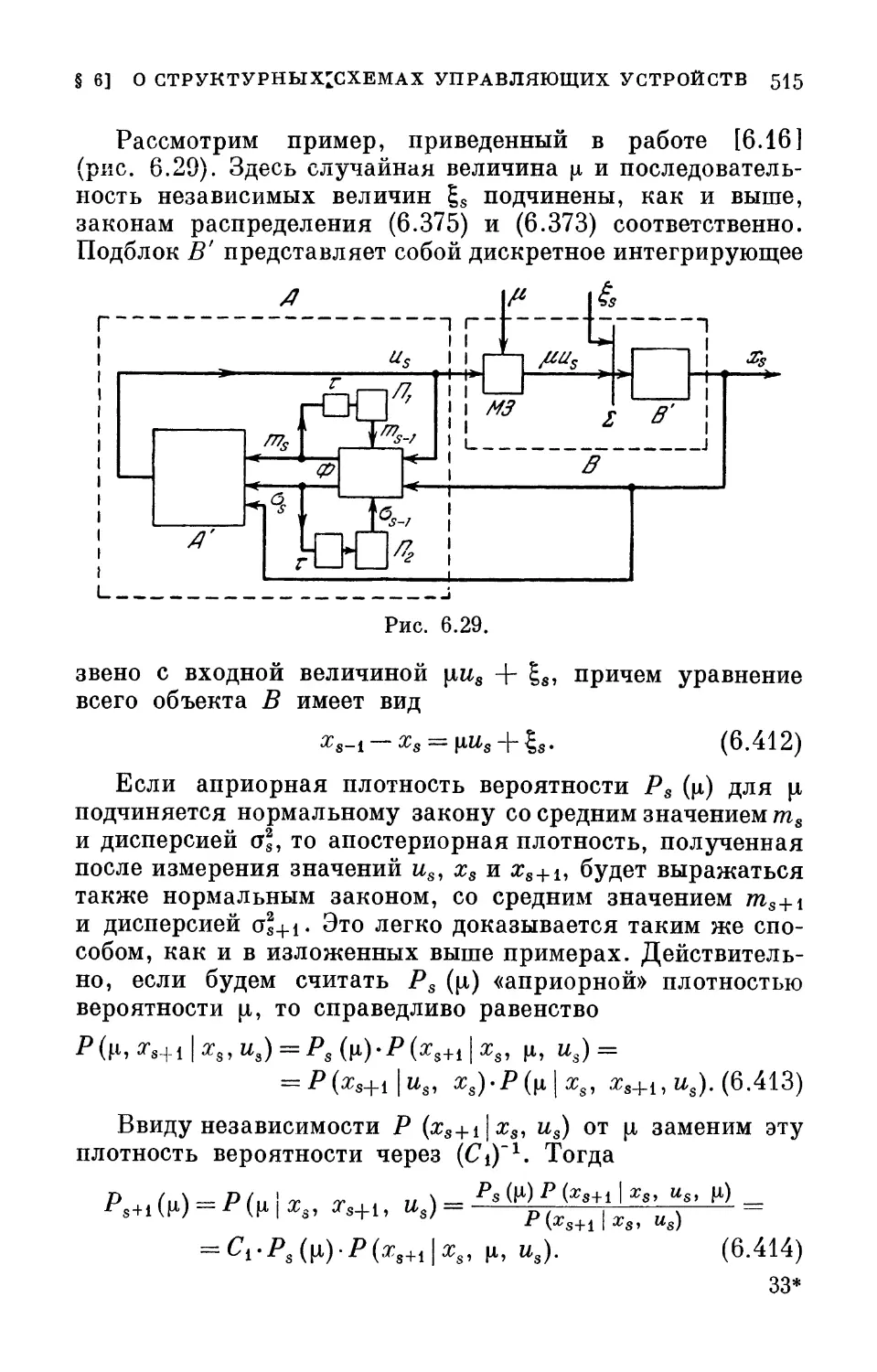

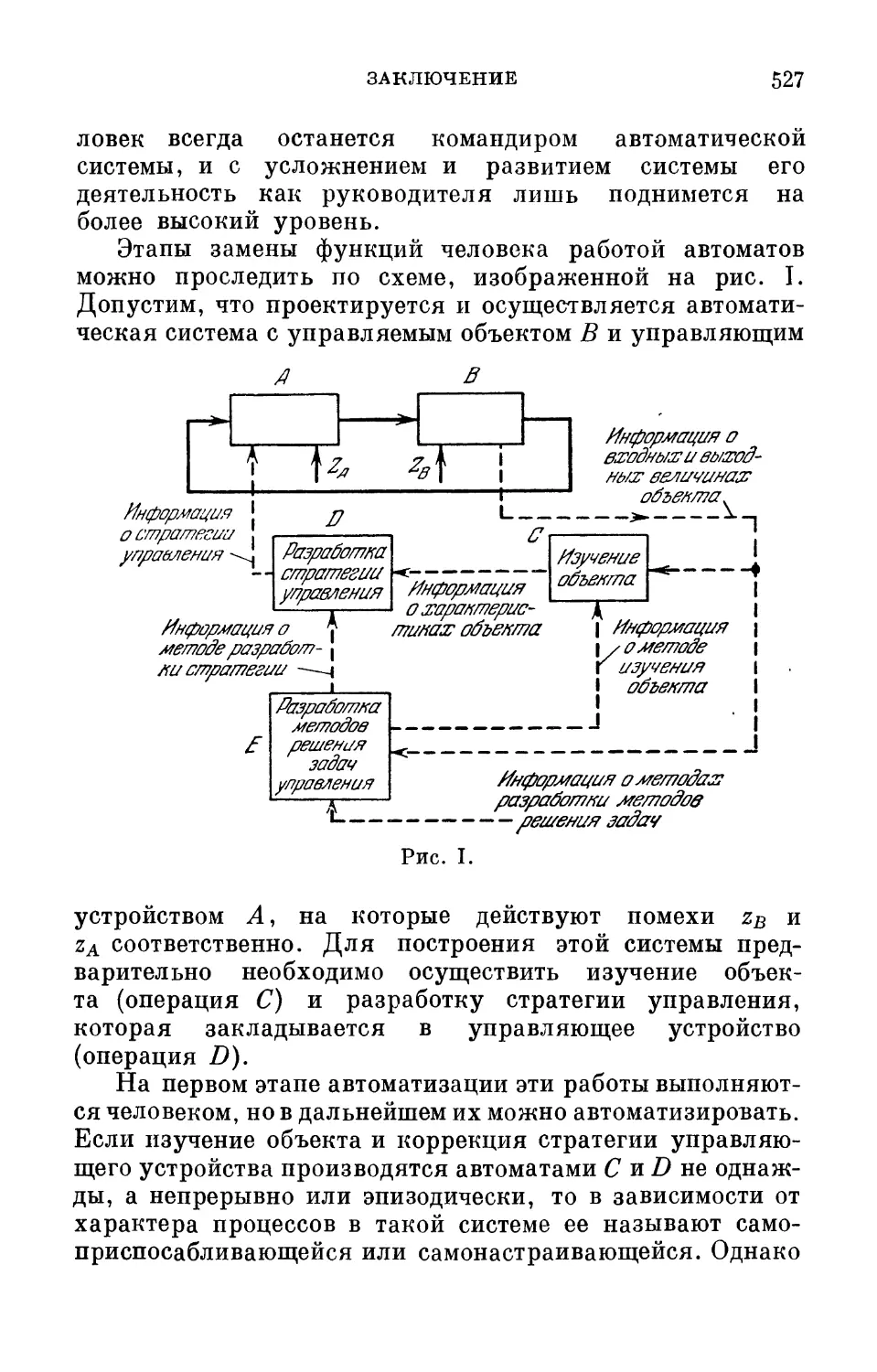

воздействие и на входе объекта В не равно, вообще говоря,