Текст

1 В. Босс

Питтл

лыъцмп

•1

г

МАТЕМАТИКЕ

Пшпня алгебра

изложение

предмета

В. Босс

по

том

3

ЛЕКЦИИ

МАТЕМАТИКЕ

Линейная алгеОра

МОСКВА

Ш55

ББК 22.143 22.144 22.151.5

Босс В.

Лекции по математике: линейная алгебра. Т. 3. — М.: КомКнига, 2005.

224 с.

I5ВN 5-484-00046-7

Книга отличается краткостью и прозрачностью изложения. Объяснения да-

даются «человеческим языком» — лаконично и доходчиво. Значительное внимание

уделяется мотивации результатов и прикладным аспектам. Даже в устоявшихся

темах ощущается свежий взгляд, в связи с чем преподаватели найдут для себя

немало интересного. Книга легко читается.

Аналитическая геометрия рассматривается как вспомогательный предмет,

способствующий освоению понятий векторного пространства. Охват линейной

алгебры достаточно широкий, но изложение построено так, что можно ограни-

ограничиться любым желаемым срезом содержания.

Для студентов, преподавателей, инженеров и научных работников.

Издательство «КомКнига». 117312, г. Москва, пр-т 60-летия Октября, 9

Подписано к печати 24.02.2005 г. Формат 60x90/16. Печ. л. 14. Заказ № 1912

Отпечатано с готовых диапозитивов во ФГУП ИП К «Ульяновский Дом печати»

432980, г. Ульяновск, ул. Гончарова, 14

I5ВN 5-484-00046-7

© КомКнига, 2005

НАУЧНАЯ И УЧЕБНАЯ ЛИТЕРАТУРА

Е-таН

Каталог изданий в Интернете:

ННр://11КЗЗ.ш

Тел./факс: 7 @95) 135-42-16

УД55 Тел./факс: 7 @95) 135-42^6

3143 Ю 26865

785484

000463

Оглавление

Предисловие к «Лекциям» 7

Предисловие к тому 9

Глава 1. Аналитическая геометрия 10

1.1. Координаты и векторы 10

1.2. Описание геометрических объектов 15

1.3. Векторное произведение 19

1.4. Определители 22

1.5. Матрицы и преобразования 23

1.6. Прямые и плоскости 29

1.7. Геометрические задачи 32

1.8. Кривые и поверхности второго порядка 35

Глава 2. Векторы и матрицы 38

2.1. Примеры линейных задач 38

2.2. Векторы 39

2.3. Распознавание образов 43

2.4. Линейные отображения и матрицы .< 45

2.5. Прямоугольные и клеточные матрицы 49

2.6. Два примера 51

2.7. Элементарные преобразования 52

2.8. Теория определителей 57

2.9. Системы уравнений 62

2.10. Задачи и дополнения 65

Глава 3. Линейные преобразования 66

3.1. Замена координат 66

3.2. Собственные значения и комплексные

пространства 68

3.3. Собственные векторы 72

4 Оглавление

3.4. Эскиз спектральной теории 74

3.5. Линейные пространства 76

3.6. Манипуляции с подпространствами 78

3.7. Задачи и дополнения 80

Глава 4. Квадратичные формы 81

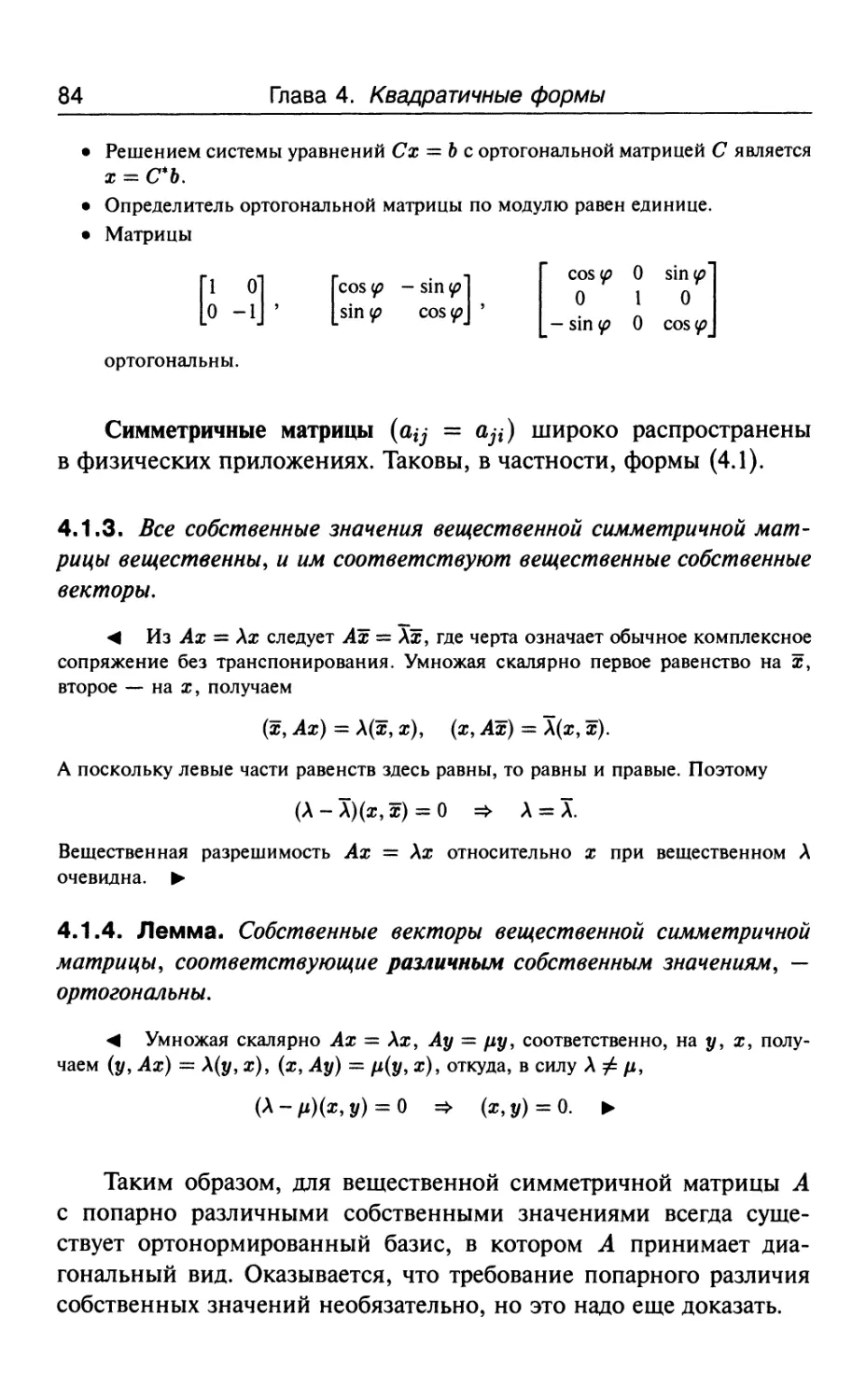

4.1. Квадратичные формы 81

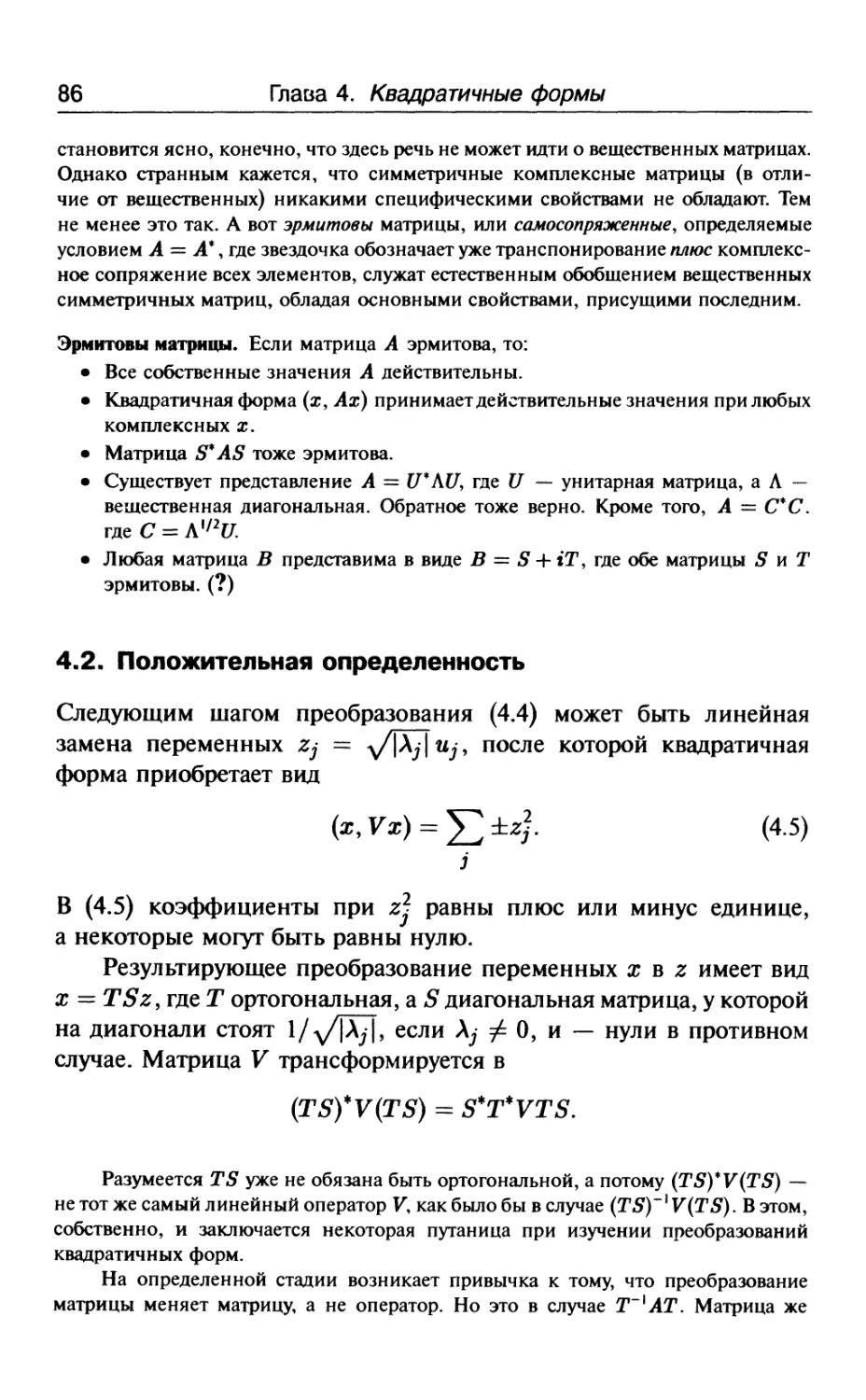

4.2. Положительная определенность 86

4.3. Инерция и сигнатура 89

4.4. Условный экстремум 90

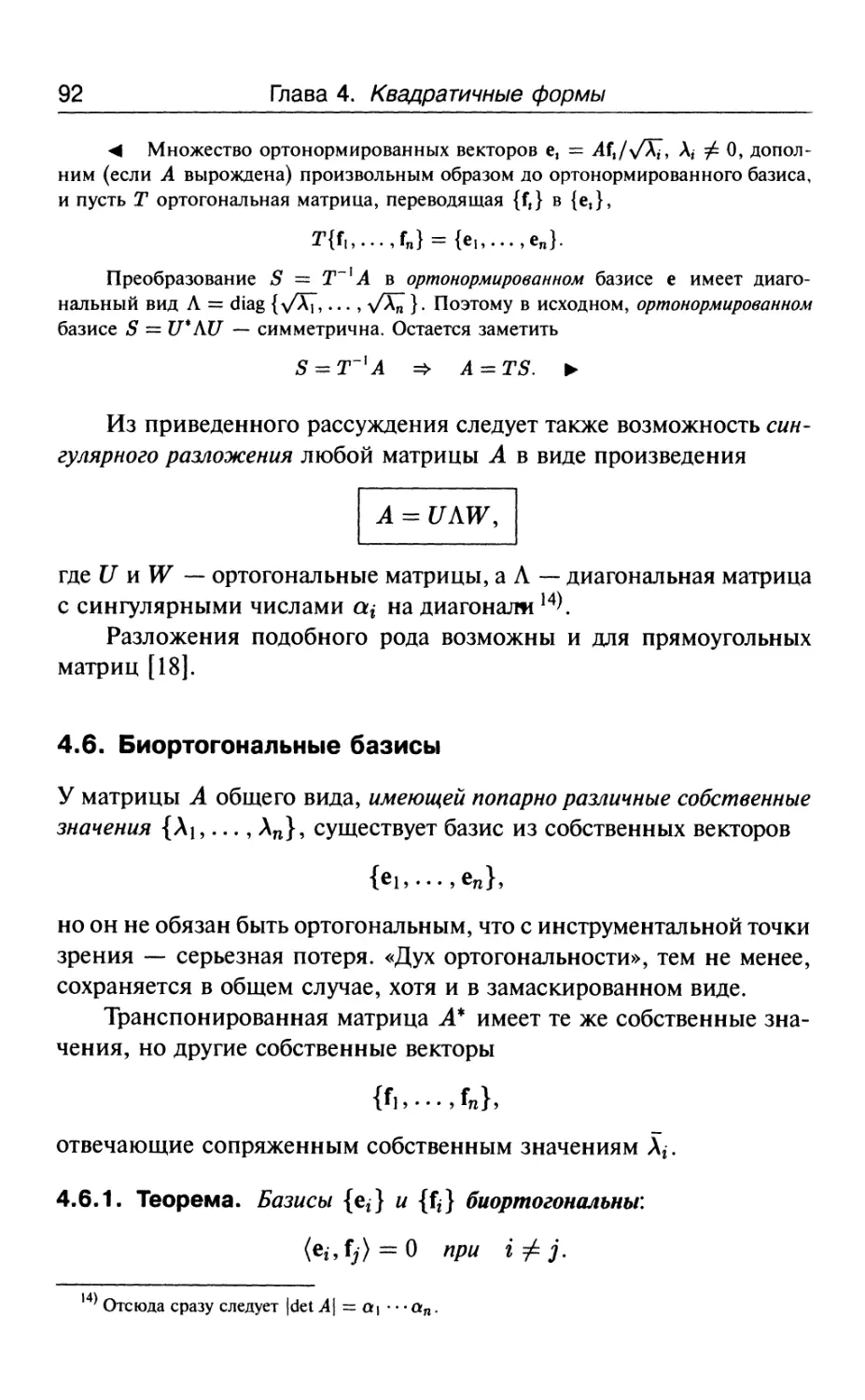

4.5. Сингулярные числа 91

4.6. Биортогональные базисы 92

4.7. Сопряженное пространство 94

4.8. Преобразования и тензоры 98

4.9. Задачи и дополнения 100

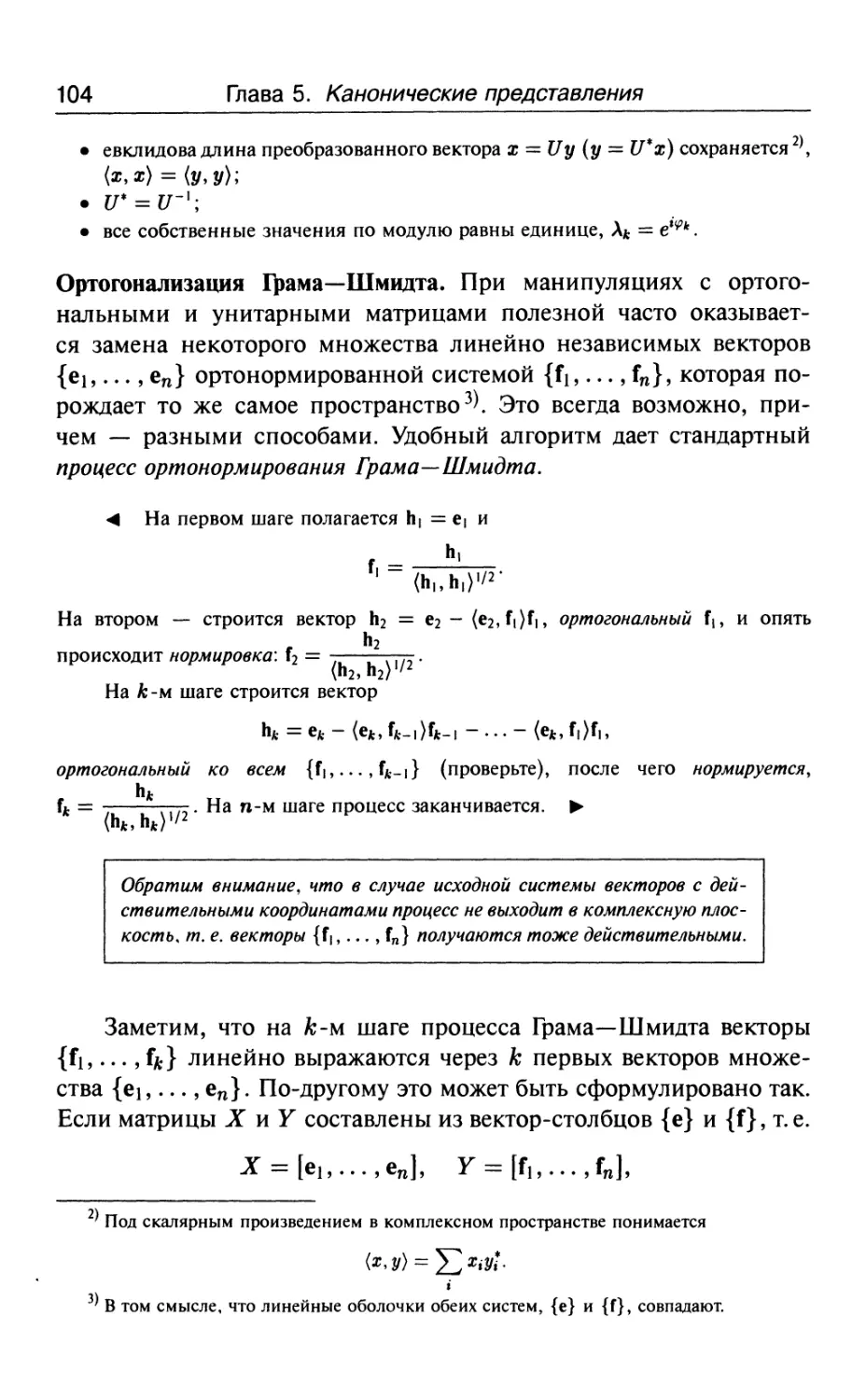

Глава 5. Канонические представления 103

5.1. Унитарные матрицы 103

5.2. Триангуляция Шура 105

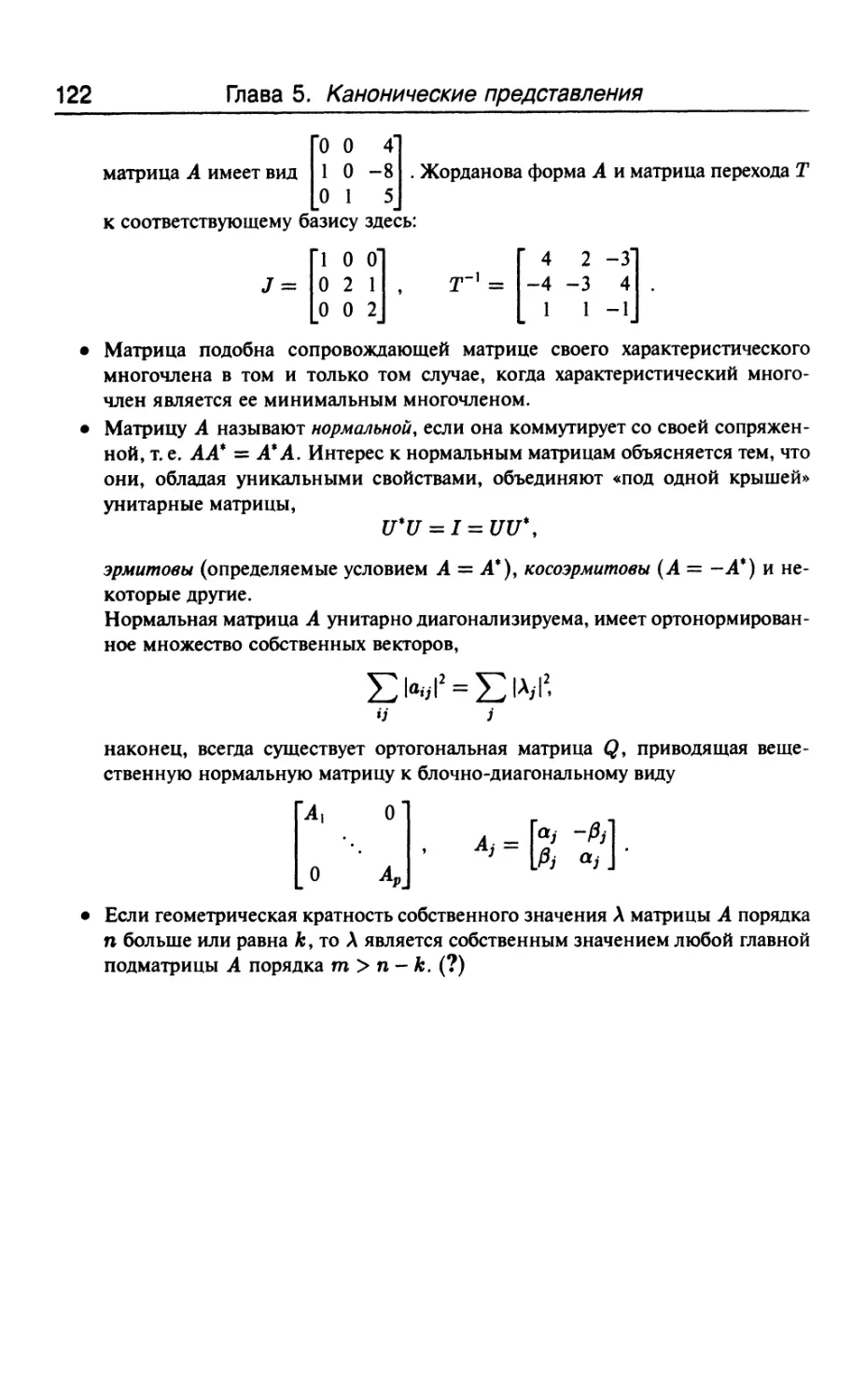

5.3. Жордановы формы 108

5.4. Аннулирующий многочлен 112

5.5. Корневые подпространства ИЗ

5.6. Теорема Гамильтона—Кэли 117

5.7. А-матрицы 118

5.8. Задачи и дополнения 120

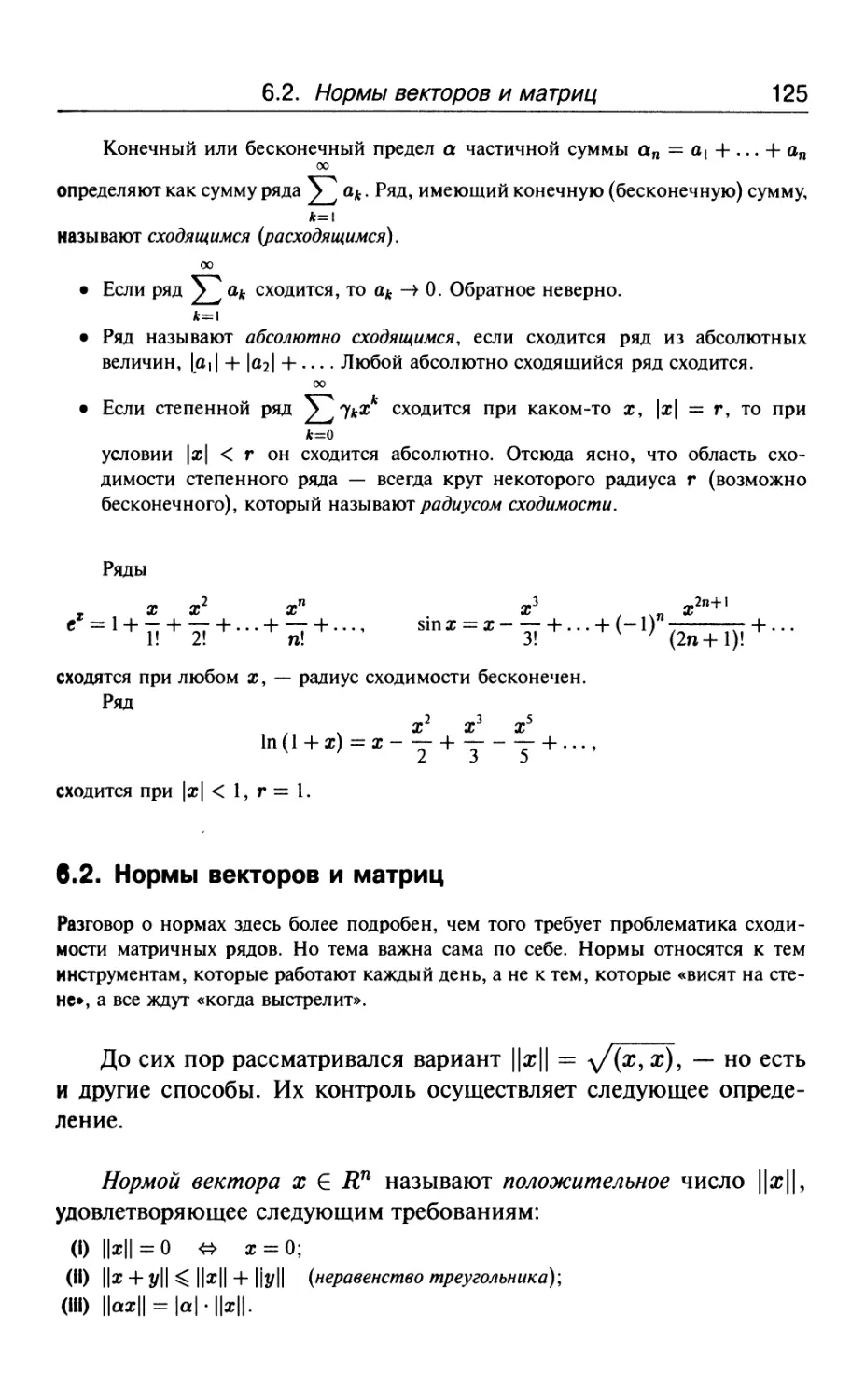

Глава 6. Функции от матриц 123

6.1. Матричные ряды 123

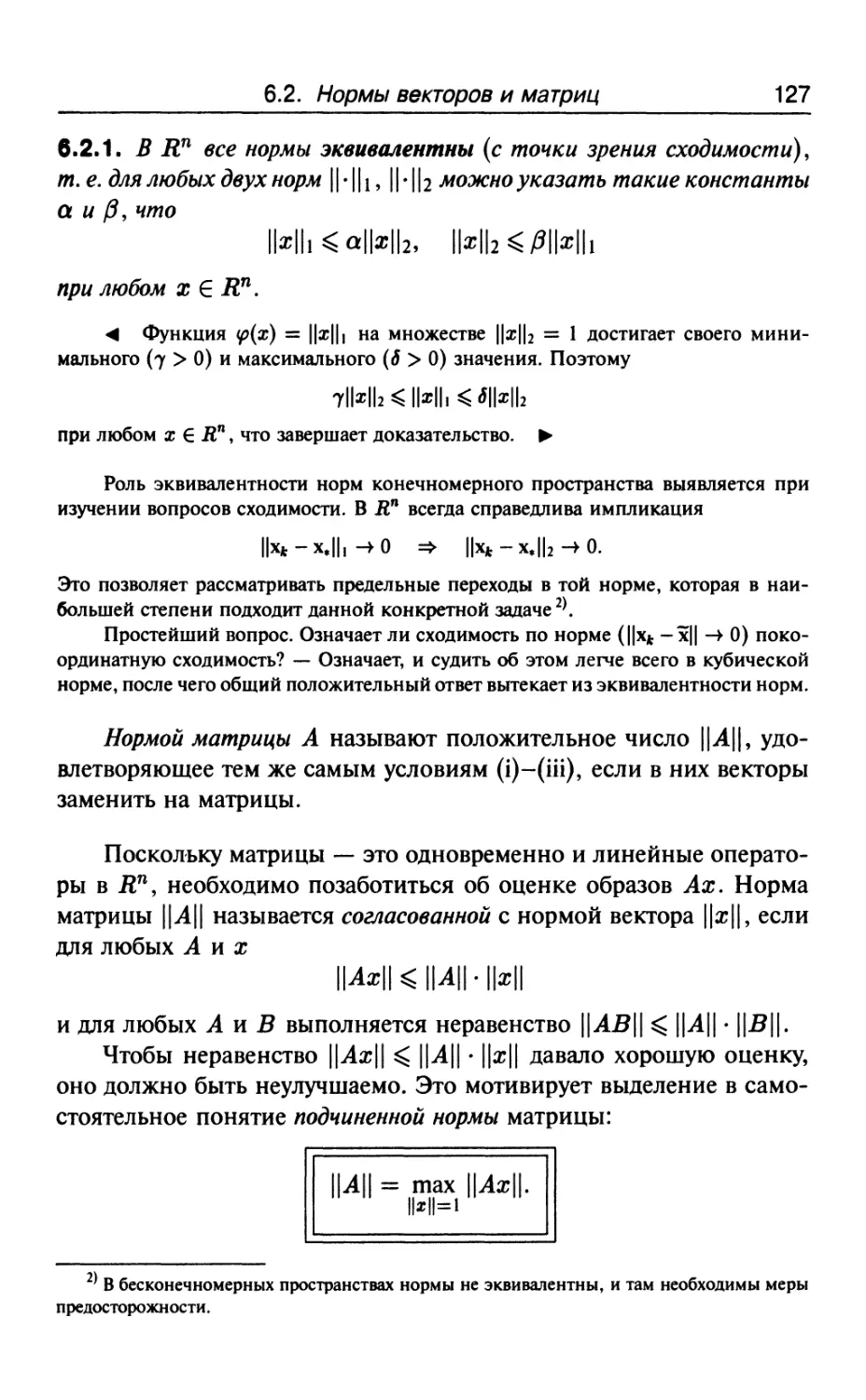

6.2. Нормы векторов и матриц 125

6.3. Спектральный радиус 130

6.4. Сходимость итераций 131

6.5. Функции как ряды 132

6.6. Матричная экспонента 133

6.7. Конечные алгоритмы 135

6.8. Задачи и дополнения 138

Оглавление 5

Глава 7. Матричные уравнения 140

7.1. Типичные задачи 140

7.2. Кронекерово произведение 141

7.3. Уравнения 143

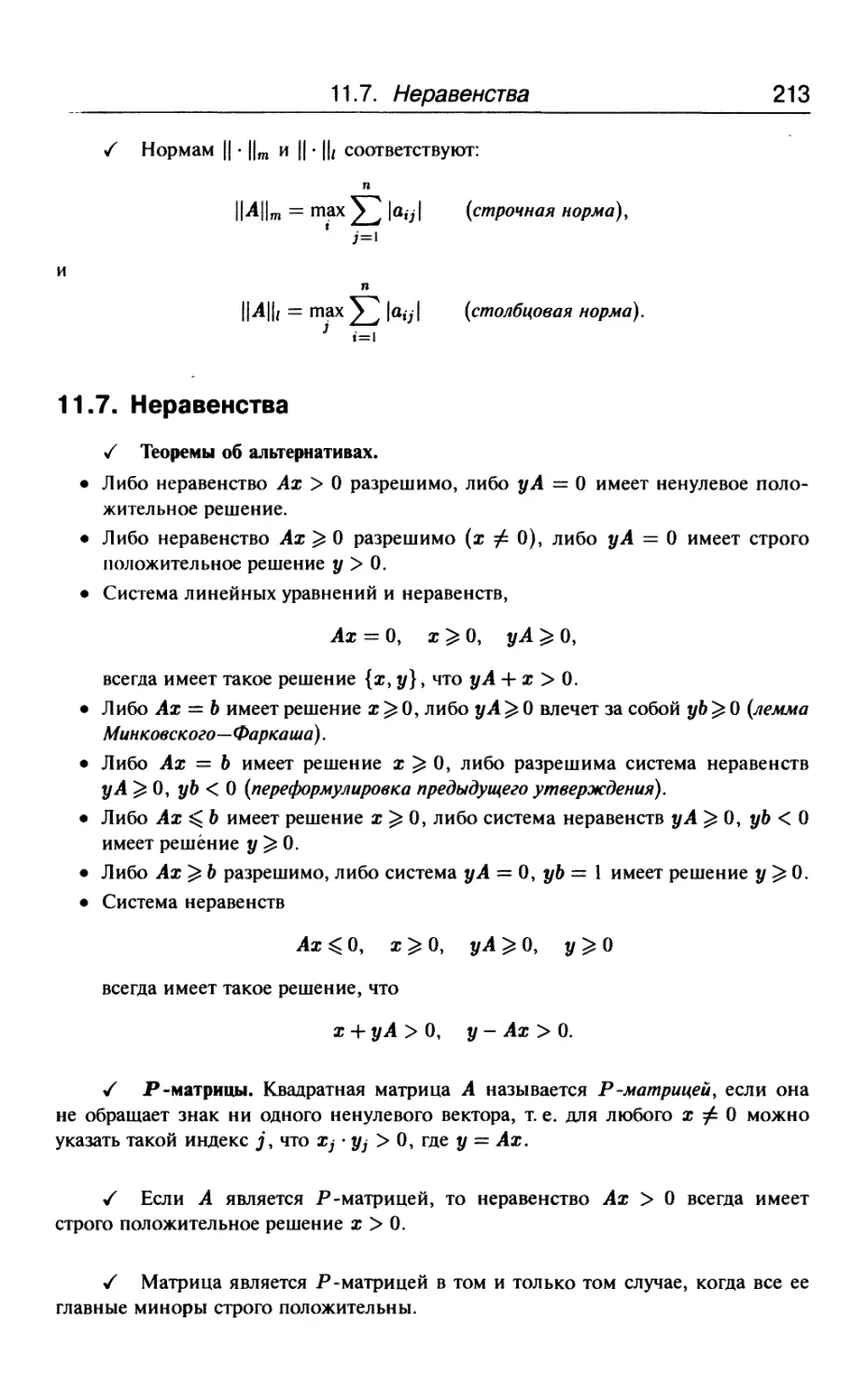

Глава 8. Неравенства 147

8.1. Теоремы об альтернативах 147

8.2. Выпуклые множества и конусы 149

8.3. Теоремы о пересечениях 152

8.4. Р-матрицы 153

8.5. Линейное программирование 156

8.6. Задачи и дополнения 161

Гпава 9. Положительные матрицы 162

9.1. Полуупорядоченность и монотонность 162

9.2. Теорема Перрона 163

9.3. Неразложимость 168

9.4. Положительная обратимость 170

9.5. Оператор сдвига и устойчивость 172

9.6. Импримитивность 176

9.7. Стохастические матрицы 177

9.8. Конус положительно определенных матриц 179

9.9. Задачи и дополнения 180

Гпава 10. Численные методы 182

10.1. Предмет изучения 182

10.2. Ошибки счета и обусловленность 184

10.3. Оценки сверху и по вероятности 187

10.4. Возмущения спектра 188

10.5. Итерационные методы 191

10.6. Вычисление собственных значений 194

Глава 11. Сводка основных определений и результатов 196

11.1. Аналитическая геометрия 196

11.2. Векторы и матрицы 200

11.3. Линейные преобразования 205

6 Оглавление

11.4. Квадратичные формы 208

11.5. Канонические представления 210

11.6. Функции от матриц 211

11.7. Неравенства 213

11.8. Положительные матрицы 214

Обозначения 216

Литература 218

Предметный указатель 219

Предисловие к «Лекциям»

Самолеты позволяют летать, но доби-

добираться до аэропорта приходится самому.

Для нормального изучения любого математического предмета

необходимы по крайней мере четыре ингредиента:

1) живой учитель',

2) обыкновенный подробный учебник;

3) рядовой задачник;

4) учебник, освобожденный от рутины, но дающий общую картину, мотивы, связи,

«что зачем».

До четвертого пункта у системы образования руки не дохо-

доходили. Конечно, подобная задача иногда ставилась и решалась,

но в большинстве случаев — при параллельном исполнении функ-

функций обыкновенного учебника. Акценты из-за перефузки менялись,

и намерения со второй-третьей главы начинали дрейфовать, не до-

достигая результата. В виртуальном пространстве так бывает. Аналог

объединения гантели с теннисной ракеткой перестает решать обе

задачи, хотя это не сразу бросается в глаза.

«Лекции» ставят 4-й пункт своей главной целью. Сопутствую-

Сопутствующая идея — экономия слов и средств. Правда, на фоне деклараций

о краткости и ясности изложения предполагаемое издание около

20 томов может показаться тяжеловесным, но это связано с обшир-

обширностью математики, а не с перефузкой деталями.

Необходимо сказать, на кого рассчитано. Ответ «на всех» вы-

выглядит наивно, но он в какой-то мере отражает суть дела. Обозри-

Обозримый вид, обнаженные конструкции доказательств — такого сорта

8 Предисловие к «Лекциям»

книги удобно иметь под рукой. Не секрет, что специалисты са-

самой высокой категории тратят массу сил и времени на освоение

математических секторов, лежащих за рамками собственной спе-

специализации. Здесь же ко многим проблемам предлагается короткая

дорога, позволяющая быстро освоить новые области и освежить

старые. Для начинающих «короткие дороги» тем более полезны,

поскольку облегчают движение любыми другими путями.

В вопросе «на кого рассчитано» — есть и другой аспект. На силь-

сильных или слабых? На средний вуз или физтех? Опять-таки выходит

«на всех». Звучит странно, но речь не идет о регламентации круго-

кругозора. Простым языком, коротко и прозрачно описывается предмет.

Из этого каждый извлечет свое и двинется дальше.

Наконец, последнее. В условиях информационного наводнения

инструменты вчерашнего дня перестают работать. Не потому, что

изучаемые дисциплины чересчур разрослись, а потому, что новых

секторов жизни стало слишком много. И в этих условиях мало

кто готов уделять много времени чему-то одному. Поэтому учить

всему — надо как-то иначе. «Лекции» дают пример. Плохой ли,

хороший — покажет время. Но в любом случае, это продукт нового

поколения. Те же «колеса», тот же «руль», та же математическая

суть, — но по-другому.

Предисловие к тому

Дом строят месяц, сдают под ключ — год.

Если что и дает ясное представление о высшей математике, так

это линейная алгебра. Барьер повседневности здесь преодолевается

легко и просто. При этом оказывается, что удивительные вещи

находятся не в туманной дали, а совсем рядом.

Для освоения, разумеется, нужна еще определенная составляю-

составляющая у вектора жизненных интересов. Некоторая готовность к труд-

трудностям и, конечно, время. Вы представьте, что переехали жить

в другой город. День-другой побродили по главным улицам. Взгля-

Взглянули на панораму с какой-нибудь вышки. Разве этого достаточно —

для знакомства? Чтобы узнать город, надо исходить его пешком.

Много раз, вдоль и поперек, и в дождь, и в снег. И в хорошем,

и в плохом настроении. Сжиться с людьми, побегать по магази-

магазинам, поездить на трамвае — и по делу, и просто так. И тогда лишь,

в тысячный раз выходя из дома, вы увидите вдруг — знакомый город.

Глава 1

Аналитическая геометрия

Аналитическая геометрия представляет собой удобную ступеньку к пониманию

линейной алгебры. Рене Декарт создавал ее, правда, с другой целью — чтобы

геометрические задачи можно было решать алгебраически. Но результат часто

не совпадает с намерением. Декартовы координаты оказались полезнее в проти-

противоположной ситуации, когда числам приписывается роль координат выдуманного

пространства. При этом, конечно, получается виртуальная фикция, но она рабо-

работает. Будит воображение там, где изначально никакой геометрии нет.

Когда дело было сделано, об аналитической геометрии стали забывать,

начиная сразу с п измерений. У подсознания ушла почва из под ног, — ибо ему

нужна другая последовательность. Геометрия, потом алгебра. Наглядность, затем

абстракция.

1.1. Координаты и векторы

Координатами называют числа, определяющие положение точки

на плоскости В? или в пространстве В?. Обозначения К2, В? —

пока для удобства. Прямоугольные {де-

{декартовы [9]) координаты точки на плос-

плоскости — суть снабженные знаками плюс

или минус расстояния от точки х до двух

взаимно перпендикулярных прямых Ох\

и 0x2 — осей координат, — точка пере-

пересечения которых считается началом ко-

координат. На рис. 1.1 точка х = {х\,Х2}

описывается двумя координатами Х\ и Х2- Горизонтальная Х\ —

называется абсциссой, вертикальная Х2 ¦— ординатой.

Систему декартовых координат в пространстве задают три вза-

взаимно перпендикулярные плоскости, относительно которых поло-

положение точки определяется тремя числами аналогично предьщущему,

х = {жьж

1.1. Координаты и векторы

11

Точку х = {х\, Х2, а?з} называют также вектором либо радиусом-

вектором. Изначально, правда, вектор определяют как направлен-

направленный отрезок прямой, изображая его со стрелочкой на конце. Однако

все векторы, которые одинаково направлены и равны по длине, счи-

считаются равными1), — что, собственно, и позволяет ограничиться

рассмотрением векторов, исходящих из начала координат.

Сумма х = {х\, Х2, Жз} и у = {у\,у2, Уз} определяется как

Х2+У2,

что равносильно сложению векторов по правилу параллелофамма,

эквивалентом которого является правило треугольника. Преиму-

Преимущества последнего выявляются при сложении нескольких векто-

векторов (рис. 1.2): каждый следующий слагаемый вектор приставляется

началом к концу предыдущего — замыкающий вектор дает сумму.

Вычитание выводится из сложения: Ь — а определяется как вектор,

который в сумме с а дает Ь. Этому соответствует простой геомет-

геометрический трюк: начала а и Ь совмещаются, а концы соединяются

отрезком, направленным к &, что и дает разность Ь — а (рис. 1.2).

Ь-а

а + Ь

Рис. 1.2

Умножение на скаляр А,

Ах = {Хх\,Хх2,

растягивает (|А| > 1) или сжимает (|А| < 1) вектор ж, не меняя на-

направления при А > 0, и меняет его на противоположное при А < 0.

*' Это характерно для идеологии свободных векторов, которая удобна в геометрических

задачах.

12 Глава 1. Аналитическая геометрия

Вектор иногда определяют как направленный отрезок, но тогда в погранич-

пограничных ситуациях возникают проблемы. Скажем, вращение около некоторой оси

на угол <р — вектор или не вектор? С одной стороны, ему можно сопоставить

направленный по оси отрезок прямой длины у?, но это не решает проблему. Не-

Неприятность заключается в том, что вращения около разных осей не складываются

по правилу параллелограмма 2\ — и это приводит к отрицательному ответу на ис-

исходный вопрос. Поэтому в подобное определение вектора необходимо добавить

требование, чтобы векторы складывались по правилу параллелофамма.

В данном контексте речь идет о математических объектах вида х = {хх, х2, х{\,

которые складываются «как надо» по определению. Что касается правил сложе-

сложения сил, моментов, потоков и других физических величин, — это задача другой

епархии.

«Второе дно». Идея декартовых координат проста до гениальности,

но громоздка, — и поначалу возникает впечатление, что вектор-

векторные понятия нужны для краткости. Это лишь половина правды.

Геометрия имеет «некоординатный» характер, и ее координатное

описание часто уводит мысль в ложном направлении. Векторный

язык точнее отражает суть геометрических свойств, что обнаружи-

обнаруживается на каждом шагу.

Векторы, лежащие на одной прямой (одинаково или про-

противоположно направленные), называют коллинеарными; лежащие

в одной плоскости, — компланарными.

Говорят, что векторы3) {хь...,х*} линейно зависимы, если

существуют такие коэффициенты А],..., Ад, не все равные нулю, что

А1Х1 + ... + А*х* = 0.

В противном случае говорят о линейной независимости векто-

векторов {хь...,х*}.

Коллинеарные векторы всегда линейно зависимы. Компланарные — линейно

зависимы, если их больше двух. (?)

Линейно независимое множество {еье2,ез} в пространстве

считается базисом, если любой вектор х можно представить в виде

2' Складываются по правилу параллелофамма бесконечно малые вращения, что влечет

за собой векторную природу угловой скорости [3].

3' Как правило, векторы с индексом выделяются жирным шрифтом, чтобы отличить их

от координат.

1.1. Координаты и векторы

13

линейной комбинации

X =

Величины Х{ называют координатами точки х ^ В?.

Стандартный базис В? (единичные векторы, орты, {е],е2,ез}

направлены по осям декартовых координат):

A.1)

1

0

0

, е2 =

0

1

0

. е3 =

0

0

1

Подготавливая плацдарм для линейной алгебры, естественно нуме-

нумеровать оси координат и орты {в|,е2,ез}, что потом облегчает

следующий шаг — тройка увеличивается до п, и обобщение готово.

Но в обычном пространстве более удобны и привычны другие обозна-

обозначения: оси координат х, у, г; соответствующие орты \, }, к, — чему

далее отдается предпочтение.

Упражнения

1. Из векторов а, Ь, с можно сложить треугольник, если а + Ъ + с = 0.

2. Любые три вектора на плоскости либо четыре — в пространстве, — линейно

зависимы.

3. Любые два не коллинеарных вектора а, Ъ определяют плоскость4\ все точки

которой могут быть записаны в виде

г = Да

4. В случае А + // = 1 точка г = Да 4- цЪ лежит на прямой, проходящей

через концы векторов а и Ь. При дополнительном условии А, [X ^ 0 точка

г = Да + //6 лежит на отрезке, соединяющем а и Ъ.

5. Если а,Ь,с — радиус-векторы вершин треугольника АВС, то

является радиусом-вектором точки пересечения медиан.

Проекция аь вектора а на вектор (направление) Ь определяется

формулой

= а СО5 (р9

' Проходящую через три точки: нуль, а и Ь.

14

Глава 1. Аналитическая геометрия

«6

Рис. 1.3

Ь

где <р — угол между векторами а и & (рис. 1.3),

не важно по малой или большой дуге измерен-

измеренный — в силу соз ср = соз Bтг — (р).

Проекции ах, ау, а2 на декартовы оси х, у, г

представляют собой координаты вектора а.

а)

Рис.1.4

При дальнейшем развитии

теории важным оказывается деле-

деление систем координат на две ка-

категории. Прямоугольную систему

Охуг называют правой, если бу-

буравчик при вращении от х к у

движется вдоль г — рис. 1.4 я,

и левой, если ось г направлена

противоположно — рис. 1.4 б.

Косоугольные координаты. Иногда декартовой называют косоугольную систему

координат общего вида, в которой координаты определяются разложением век-

вектора5* — рис. 1.5 — по двум (на плоскости) или

по трем (в пространстве) направлениям, которые

не обязательно взаимно перпендикулярны.

Атрибутом «декартовости» при этом явля-

является наличие базиса. Примером не декартовых

координат могут служить (нелинейные) поляр-

: " ^ ные координаты (вектор характеризуется длиной

г и углом (р с выделенным направлением).

Рис.1.5

В общем случае не прямоугольных координат понятие ориентации опи-

опирается на следующее определение. Упорядоченная тройка некомпла-

некомпланарных векторов а,Ъ,с, исходящих из точки 0, называется правой,

если для наблюдателя, расположенного в нуле, обход концов а, 6, с

в указанном порядке происходит по часовой стрелке. В противном

случае тройка а,Ъ,с — левая. Соответственно классифицируются

базисы.

' Операция разложения вектора по заданным направлениям известна со школы (разло-

(разложение сил, скоростей на несколько составляющих — две на плоскости, три в пространстве),

и заключается в построении подходящего параллелограмма (либо параллелепипеда) с по-

последующим представлением диагонали в виде векторной суммы сторон.

1.2. Описание геометрических объектов

15

Если не оговорено прошивное, под декартовыми — подразумеваются далее

прямоугольные координаты.

1.2. Описание геометрических объектов

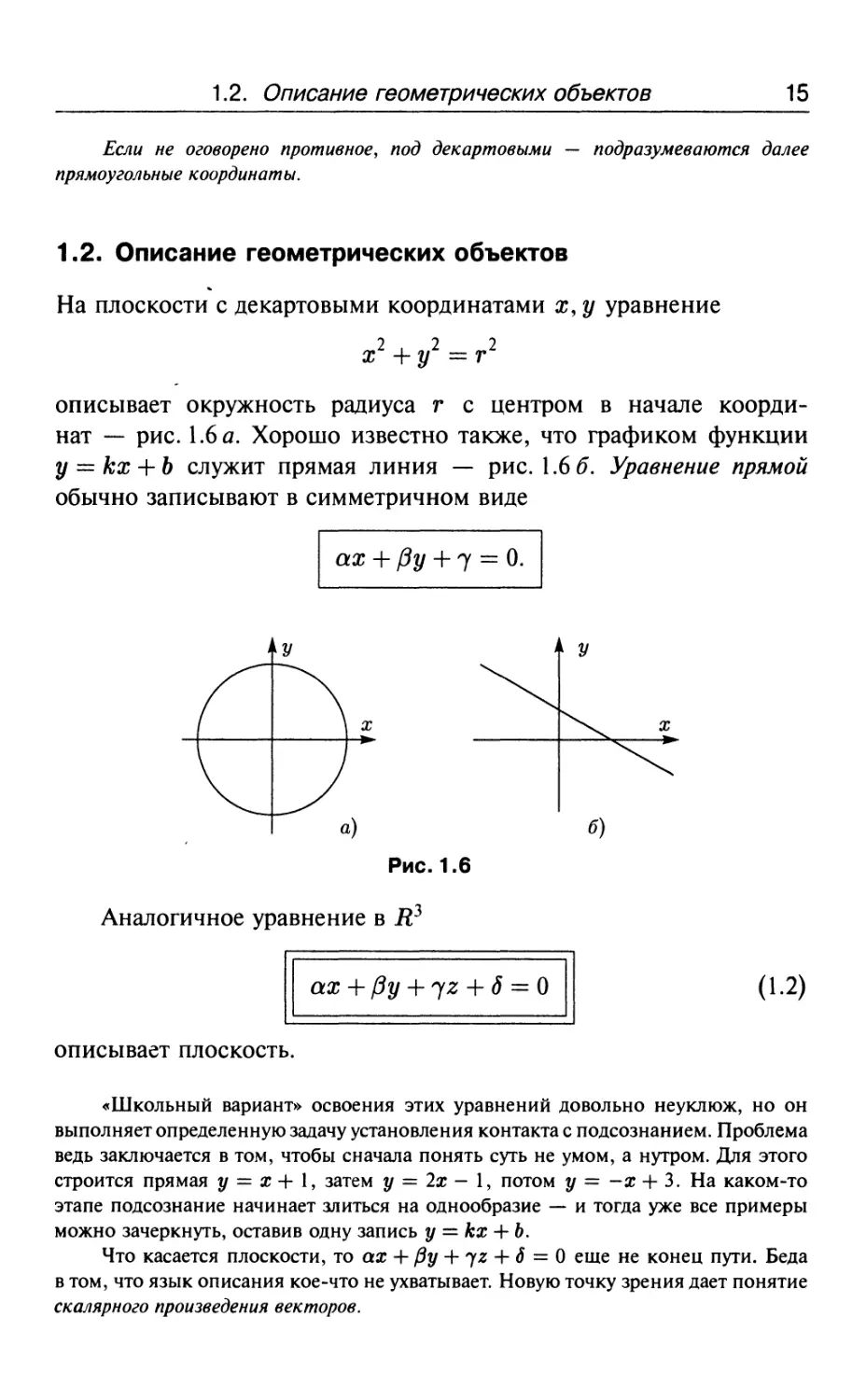

На плоскости с декартовыми координатами ж, у уравнение

описывает окружность радиуса г с центром в начале коорди-

координат — рис. 1.6 а. Хорошо известно также, что графиком функции

у = кх + Ъ служит прямая линия — рис. 1.66. Уравнение прямой

обычно записывают в симметричном виде

ах + (Зу + 7 = 0.

Рис. 1.6

Аналогичное уравнение в К3

ах + {Зу + 72 + 6 = 0

A.2)

описывает плоскость.

«Школьный вариант» освоения этих уравнений довольно неуклюж, но он

выполняет определенную задачу установления контакта с подсознанием. Проблема

ведь заключается в том, чтобы сначала понять суть не умом, а нутром. Для этого

строится прямая у = х -+- 1, затем у = 2х — 1, потом у = -х 4- 3. На каком-то

этапе подсознание начинает злиться на однообразие — и тогда уже все примеры

можно зачеркнуть, оставив одну запись у = кх + Ь.

Что касается плоскости, то ах + @у 4- у г + 6 = 0 еще не конец пути. Беда

в том, что язык описания кое-что не ухватывает. Новую точку зрения дает понятие

скалярного произведения векторов.

16

Глава 1. Аналитическая геометрия

Скалярное произведение определяется как произведение длин

векторов на косинус угла между ними6) (рис. 1.7),

х • у = \х\ • \у\

A.3)

Рис.1.7

Другими словами, ху (точка в

обозначении скалярного произведения

часто опускается) есть произведе-

произведение длины х на проекцию вектора у

на вектор ж, т.е.

ху = \х\ух.

Для обозначения скалярного произведения используется также более гро-

громоздкая, но иногда полезная запись (ж, у).

Скалярное произведение удовлетворяет обычным свойствам

умножения:

Ху = ух (коммутативность),

х(у + х) = Ху + XX (дистрибутивный закон).

Второе вытекает из равенства проек-

проекции суммы векторов — сумме проек-

проекций.

Отметим попутно, что длина \а\

(еще говорят — норма, и пишут ||а||)

вектора а = {ах, ау} по теореме Пи-

Пифагора равна (рис. 1.8)

Рис. 1.8 \\п\\ -

т. е. а2 = а- а =

В пространстве, соответственно,

\а\\2 = а2 =

6' Из-за четности и периодичности косинуса, созBтг - <р) — со$^>, — не важно, как

измеряется угол.

1.2. Описание геометрических объектов

17

откуда

что приводит к

(а ± бJ = (о, ± Ы2 + (в, ± Ь,J + (а, ± ЬгJ,

и (а + бJ - (а - бJ

а • о = = ахох + ау0у + агог.

Последнюю формулу

а-Ь = ахЪх

ауЬу

A.4)

иногда принимают за исходное определение скалярного произве-

произведения, выводя A.3) в качестве следствия.

Произведение а • Ъ = \а\ • |5| соз гр отражает широко распространенный в при-

природе способ взаимодействия векторов, характеризуемый умножением длины од-

одного вектора на проекцию другого: \а\Ьа. Например, работа силы Р на переме-

перемещении 5 равна

Р - 8 = \Р\ • \з\со5(р,

поскольку «работает» только составляющая Р, направленная вдоль 5.

Поток жидкости через площадку площади А5 равен скалярному произве-

произведению уАЗ, где V — скорость течения (в районе А5), а вектор А5 считается

направленным по нормали к площадке. Физически опять-таки понятная ситу-

ситуация: количество жидкости, протекающей через Д5, определяется нормальной

составляющей потока и не зависит от касательной составляющей.

Скалярное произведение — удобный инструмент при решении

многих задач. Пусть, скажем, исходная декартова система коор-

координат имеет орты \,},к, а новая (тоже декартова) — орты \',}[ к'.

Поскольку координаты вектора а = {ах,ау,аг} — есть проек-

проекции а на оси х,у,г, в новой системе

координаты а' = {ах,,а',,а'2,} — сно-

снова проекции, но уже на оси х',у',г'.

Поэтому, например,

где коэффициенты дают запись орта

1' = {гх,1у,г'г} в старой системе коор-

координат.

Рис. 1.9

18

Глава 1. Аналитическая геометрия

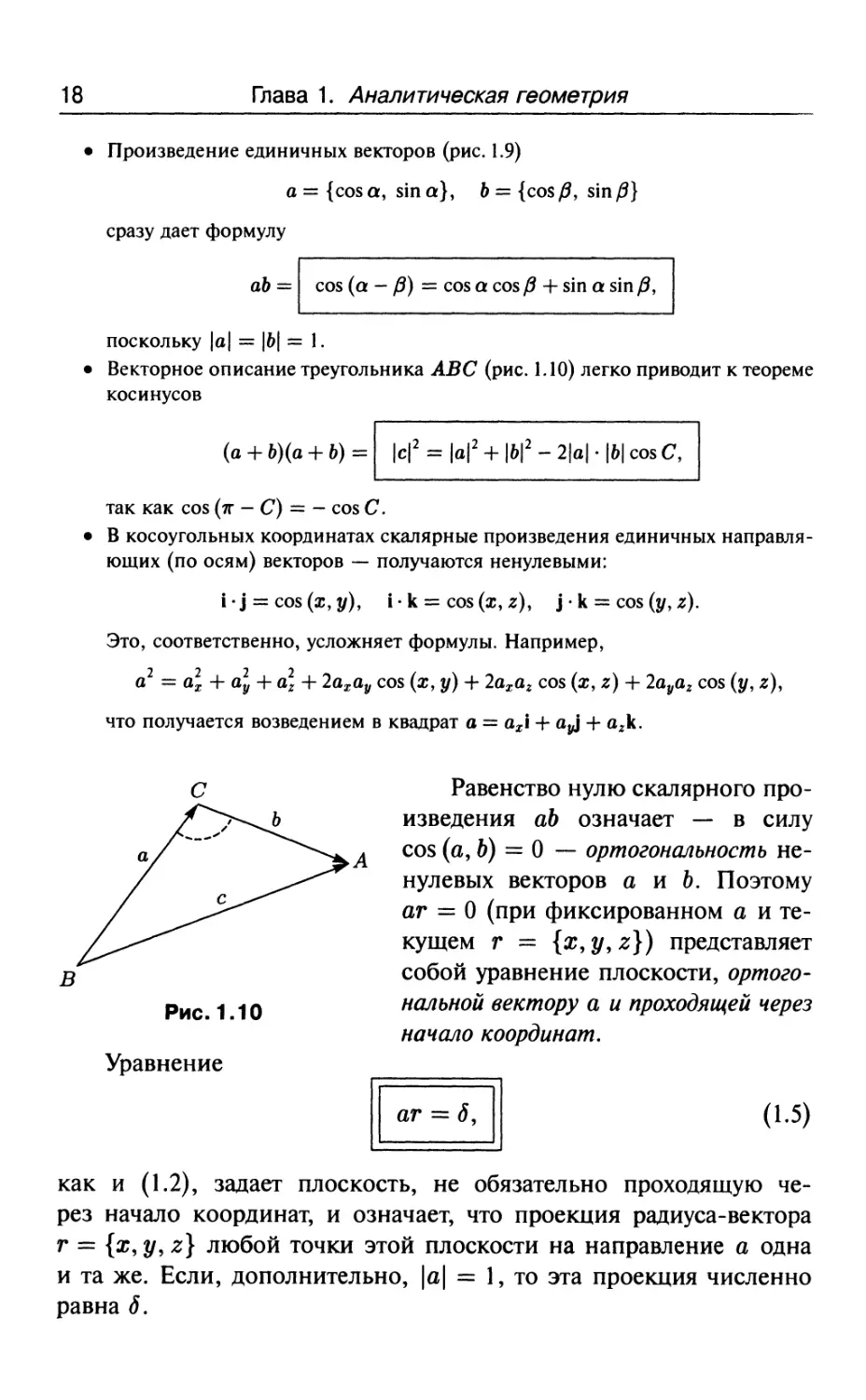

Произведение единичных векторов (рис. 1.9)

а = {соза, зша}, Ь = {соз/?, зш/?}

сразу дает формулу

соз (а - /3) = соз а соз /3 + зт а зт /3,

поскольку \а\ = |6| = 1.

Векторное описание треугольника АВС (рис. 1.10) легко приводит к теореме

косинусов

(а + 6)(а + Ь) =

|6|2-2|а|-|6|созС,

так как соз (тг - С) = - соз С.

• В косоугольных координатах скалярные произведения единичных направля-

направляющих (по осям) векторов — получаются ненулевыми:

1-} = со$(х,у), I • к = соз (ж, г), \ • к = соз (у, г).

Это, соответственно, усложняет формулы. Например,

а2 = а2х + а2у + а\ + 2ахау соз (ж, у) + 2ахаг соз (ж, г) + 2а^аг соз ($/, г),

что получается возведением в квадрат а = ах1 + а>у\ + агк.

Равенство нулю скалярного про-

произведения аи означает — в силу

соз (а, Ь) = 0 — ортогональность не-

ненулевых векторов а и Ъ. Поэтому

аг = 0 (при фиксированном а и те-

текущем г = {ж, 2/, г}) представляет

собой уравнение плоскости, ортого-

ортогональной вектору а и проходящей через

начало координат.

Рис. 1.10

Уравнение

аг = 6,

A.5)

как и A.2), задает плоскость, не обязательно проходящую че-

через начало координат, и означает, что проекция радиуса-вектора

г = {х, у, г} любой точки этой плоскости на направление а одна

и та же. Если, дополнительно, \а\ = 1, то эта проекция численно

равна д.

1.3. Векторное произведение 19

Понятно, что A.5) лишь другая (векторная) форма записи

уравнения A.2), но она привносит дополнительную интерпретацию,

которая позволяет наглядно мыслить.

Прямые и плоскости в евклидовой геометрии — одни из основ-

основных объектов. Соответствующую роль в аналитической геометрии

играет уравнение A.5), манипуляции с которым помогают описать

многие задачи. Например, совокупности двух уравнений

аг — 5, Ьт — ^

удовлетворяет прямая в В? (пересечение плоскостей).

Понятия точки, прямой и плоскости в геометрии Евклида первичны и пото-

потому — неопределяемы. Аналитическая геометрия дает определение этих понятий7*,

но никакого чуда при этом не происходит — первичные понятия отодвигаются

в другую область.

1.3. Векторное произведение

Векторное произведение,

с = ах Ь,

определяется как вектор с, ортогональный векторам а и Ь, и состав-

составляющий тройку {а,Ъ,с}, совпадающую по ориентации с тройкой

базисных векторов, а длина с равна

площади параллелограмма, построен-

построенного на векторах а, Ь (рис. 1.11),

\с\ = \а\ • \Ь\ ы

Часто подразумевают, что система коор- Рис. 1.11

динат правая, — тогда проблему направления

с решает «правило буравчика», и странность определения с = а х Ь забывается.

«Странность» заключается в том, что векторное произведение ах Ь как бы ощу-

ощущает ориентацию пространства (меняет направление при замене левой системы

координат на правую). Такие векторы называют аксиальными, и даже — псев-

псевдовекторами. Обычные векторы (сила, скорость) — их называют полярными —

на замену системы координат не реагируют8).

7* Как множеств решений тех или иных уравнений.

'Реагирует их описание. При замене координат {х,у,г} на {—х, — у, — г\ описание

полярного вектора {ах, ау,аг} переходит в {-ах, -ау, —а2}. Запись аксиального — не ме-

меняется.

20

Глава 1. Аналитическая геометрия

Векторное произведение не ассоциативно,

(охб)хс^ох(Ьхс),

антикоммутативно,

х х у = -у х ж,

но справедлив дистрибутивный закон,

A.6)

проверка которого требует некоторых усилий.

^ Для обоснования A.6) представим вектор х в виде суммы х = х±

где составляющая х± перпендикулярна вектору и, а х\\ — параллельна. Очевидно,

ххи = х±хи, (х + у)± = х±+ у±.

Равенство A.6) теперь следует из почти очевидного

Линейная скорость V конца

радиуса-вектора г при вращении

вокруг оси, проходящей через на-

начало координат О, с угловой ско-

скоростью ш равна

V = Ш X Г,

A.7)

где (пока формально) вектор ш на-

направлен по оси вращения (в сто-

сторону, определяемую по «правилу

буравчика», рис. 1.12).

Если тело участвует в двух вращениях ш1 и ш2 (с пересекаю-

пересекающимися осями), то линейные скорости

V = Ш X Г И V = Ш X Г

складываются как векторы, и в силу A.6) —

V = ш1 х г + ш2 х г = (а;1 + а;2) х г.

Это означает, что результирующее движение происходит с угло-

угловой скоростью ш = ш1 -Ьо;2. Таким образом, угловые скорости

складываются по правилу параллелограмма, и поэтому являются

полноценными векторами9).

' Аксиальными.

(«

(а

(а

X

X

X

«А

а>гЪх

ахЬу

-агЬу,

- ахЬг,

- ауЬх.

1.3. Векторное произведение 21

В правой декартовой системе координат:

что совместно с дистрибутивным законом A.6) легко приводит10) к формулам,

определяющим координаты векторного произведения а х Ь:

A.8)

Векторное произведение оказывается удобным инструментом при описании

многих физических явлений.

Моментом силы Р относительно точки О называется вектор

М = гхР.

Аналогично определяется момент количества движения:

N = г х ту.

Дифференцируя 14, получаем

N = г х ту + г х ту = г х ту = г х Р = М,

поскольку ту = Р и г х ту = у х ту = 0.

Вот несколько примеров из геометрии.

• Раскрытие скобок в (а + Ь) х (а - Ъ) приводит к

(а + Ь) х (а - Ь) = -2а х &,

откуда следует, что площадь параллелограмма, построенного на диагоналях,

в два раза больше площади исходного параллелограмма.

• Перемножение векторов, изображенных на рис. 1.9, дает (в случае правой

ориентации {1,,|,к})

а х Ъ = - 8И1 (а - /3) к,

т. е. ненулевой является только координата

(а х Ь)г = ахЬу - ауЬх = со$ а зш р - &\п а со$ р.

Поэтому

81П(а -/3) = втасов/3 - со$а$тр.

• Уравнением прямой, параллельной вектору а и проходящей через точку Ь

(конец вектора &), служит

(г - Ь) х а = 0.

10)

В результате раскрытия скобок в (ах1 + ау\ + а2к) х (ЬХ1 + Ьу\ + Ь2к).

22

Глава 1. Аналитическая геометрия

1.4. Определители

Объем V параллелепипеда, построенного на векторах а, Ь, с (как

на ребрах), определяется смешанным произведением

а-(Ьхс) = ±У,

где Ь х с дает площадь параллелограмма, лежащего в основании,

а проекция аьхс — высота параллелепипеда. Что касается знака,

то плюс получается в ситуации, когда ориентация тройки {а, Ь, с}

такая же, как у базиса, минус — в противном случае (базис левый,

тройка {а, Ь, с} правая; либо наоборот).

В случае компланарных векторов а • (Ь х с) = 0, поскольку параллелепипед

сплющен, и его объем — нуль.

Рутинное перемножение векторов в координатной форме после исключения

нулевых членов приводит к

а(Ьх с) = ахЬус2 - ахЬ2Су + ауЬ2сх - ауЬхс2 + а2ЬхСу - агЬусх. A.9)

Тот же результат, что и A.9), дает раскрытие определителя, или

детерминанта

ах ау а2

Ьх Ьу Ьг

сх су сг

A.10)

общая теория которых будет изложена в следующей главе, но част-

частные случаи определителей 2-го и 3-го порядков — это те самые при-

примеры, которые более поучительны,

чем правила.

Детерминант второго порядка по оп-

определению равен

ах ау

= ахЬу - ауЬх.

A.11)

Если ось г перпендикулярна плоскости

векторов а, 6, то аг = Ьг = 0 и из фор-

формул A.8) для векторного произведения ста-

становится понятно, что детерминант A.11)

равен, по модулю, площади параллело-

параллелограмма, построенного на векторах а и 6.

1.5. Матрицы и преобразования

23

С учетом A.11) отсюда следует, что площадь параллелограмма О АС В (рис. 1.13)

равна разности площадей прямоугольников ООН К и ОЛЕР. Вне векторной

идеологии это не такая уж легкая геометрическая задача.

Сопоставление A.11) с A.9) приводит к равенству

ах ау а2

Ьх Ьу Ьг

Сх Су С2

= ах

Ьу Ь2

су с2

~пУ

ьх ь2

сх с2

ьх ьу

сх су

A.12)

которое сводит вычисление детерминанта 3-го порядка к вычислению детерми-

детерминантов 2-го порядка.

Из этой формулы следует, что векторное произведение а на & можно записать

в форме определителя

^ к

а х Ь =

ах ау а2

Ьх Ьу Ь2

где У, к — единичные орты.

1.5. Матрицы и преобразования

При манипулировании векторами часто встречается квадратная таблица чисел

вида

\ах ау аЛ

\ЬХ Ьу Ъх\,

которая фигурировала в записи определителя A.10). На такую таблицу можно

смотреть как на координатную запись друг под другом трех векторов (вектор-

строк) а, &, с; либо как на координатную запись в строчку трех вектор-столбцов

Более удобной оказывается запись таких таблиц (матриц) в виде

A.13)

А =

аи п\2 а\з

п2\ а22 0,23

«31 «32 «33

где первый индекс у элемента ац обозначает номер строки, вто-

второй — столбца. При этом через аг: будем обозначать г-ю строку А,

24

Глава 1. Аналитическая геометрия

через а^ — ^-и столбец, т.е.

Матрицы как операторы. Матрица A.13) чаще всего возникает как

таблица коэффициентов линейного преобразования

= а,

а22у

A.14)

переводящего вектор г = {ж, $/, г} в вектор й = {а, /?,7}.

Преобразование A.14) записывают в виде Ат = й, что опреде-

определяет по сути правило умножения матрицы на вектор и позволяет

смотреть на матрицу как на линейный оператор11), действующий

в пространстве трех переменных и преобразующий векторы по ука-

указанному правилу.

Если на произведение С = АВ матриц А = [ау] и В = [Ьу]

смотреть как на последовательное применение линейного операто-

оператора В, потом А, то правило умножения матриц

A.15)

получается обыкновенным приведением подобных в равенстве

Сх = АВж =

Из A.15) видно, что элемент сц матрицы С получается ска-

скалярным умножением вектор-строки аг: на вектор-столбец Ь у, т. е.

у = аг: • Ь :;- .

) Отображение, функцию.

1.5. Матрицы и преобразования

25

0

0

0

1

0

0'

0

1

Обратной к А называют матрицу А 1, такую что

где / — единичная матрица,

Т

определяющая тождественное преобразование 1х = х.

Наконец, матрица А* с элементами а*^ — а^ (строки становят-

становятся столбцами, столбцы — строками) называется транспонированной

к А. Вместо А* используются также равноценные обозначения АТ

либо А'.

Легко проверяется, что \А\ = \А*\.

Линейные уравнения. На A.14) можно смотреть также как на уравнение относи-

относительно г = {х, у, г] при заданном д, = {а, /3,7}.

Здесь полезно рассмотрение уравнения A.14) с разных точек зрения. С одной

стороны, A.14) есть

1~а1 1~°п1

т. е. решение {ж, у, г\ представляет собой координаты

вектора <к = \Р\

Ы

в базисе

При этом понятно, что вектор-столбцы могут составлять базис, если они неком-

некомпланарны (не лежат в одной плоскости). Для этого необходимо и достаточно,

чтобы определитель \А\ был не равен нулю.

С другой стороны, A.14) можно рассматривать как

A.16)

где

а = {аи, 012,

Ь = {а2\,а22,

с = {азиап, а33}.

26 Глава 1. Аналитическая геометрия

Каждое из трех уравнений A.16) описывает плоскость — см. A.5), — причем

векторы а, &, с перпендикулярны к этим плоскостям. Понятно, что плоскости

пересекаются в единственной точке, если нормали а, &, с некомпланарны, для

чего опять-таки необходимо и достаточно \А\ Ф 0. Остальные возможности

геометрически также очевидны |2).

Хотя решить линейную систему уравнений численно всегда легко после-

последовательным исключением переменных, интерес представляют единообразные

формулы и возможные интерпретации.

С целью получения общего решения A.16) рассмотрим сначала систему

A.17)

Поскольку в A.17) скалярное произведение г на & и на с равно нулю, то г

перпендикулярен Ь и с, т. е. параллелен &хс, а значит г = А(&хс) при некотором А,

которое определяется подстановкой г = А(& х с) в первое уравнение A.17), откуда

А[а-(Ьхс)] = 1 =^ А=— =^ г = —тг^-т-

а(Ьхс) а(Ьхс)

Обозначая полученное решение г через а° и два аналогичных через Ь° и с°,

в _ (Ьхс) _ (сха) о _ (ахЪ)

а(ЬхсУ а (Ьхс)' а (Ьхс)'

имеем

A.18)

Умножая теперь системы A.18), соответственно, на а,/?, 7 и складывая,

получаем

а • (аа° 4- ($Ь° 4- 7е) = <*>

Ь • (аа 4- /?&° 4- 7с°) = /?,

с • (аа° 4- РЬ° 4- 7С°) = 7'

откуда видно, что

г = аа + (ЗЬ° 4-7С° A.19)

является решением системы A.16).

'У плоскостей может не быть общей точки пересечения (решение системы A.16)

невозможно). Либо пересечением плоскостей является прямая — решений системы A.16)

бесконечно много.

1.5. Матрицы и преобразования

27

Таким образом, знание Векторов а°, &°, с позволяет практически мгновенно

|>ешать исходную систему уравнений A.16) при любой правой части.

Говорят, что векторы а°,Ъ°,с взаимны по отношению к а,Ъ,с. Из A.18)

видно, что точно так же а, 6, с взаимны по отношению к а° ,Ь°, с°. Очевидно,

ау

Ох К

О |О

пу Оу

аг К

Су

О

=

0

0

0

1

0

0"

0

1

т. е. матрица, составленная из вектор-столбцов а°, &°, с , является обратной по от-

отношению к исходной. Именно поэтому система A.16) сразу решается, как только

определены а°, Ь°, с . На матричном языке это выглядит тривиально. Уравнение

Ат = 6, после умножения слева на А~] переходит в г = А~хй, что сразу дает

решение, т. е. выражает г через д..

Правило Крамера. Многое из сказанного может показаться переливанием из пу-

пустого в порожнее, поскольку мы толчемся вокруг да около. Как решить систему —

ясно, а смена позиций меняет форму, но ничего не прибавляет по существу.

По крайней мере, так кажется. Тем не менее разные взгляды на один и тот же

факт позволяют математике расти и достигать новых областей, очень далеких

от первоначальных постановок задач. Разные взгляды — разные ассоциации,

связи, возможные обобщения.

Остановимся еще на одной интерпретации, для чего перенумеруем перемен-

переменные, считая г = {х\, х2, ж3}, и перепишем систему уравнений A.14) в виде

а,,ж, 4- а,2ж2

— а,

A.20)

т. е. по-прежнему Ат = Л.

Пусть Х> = \А\, а ^^ обозначает определитель матрицы, которая получается

из А заменой 1-го столбца на вектор-столбец Л. Тогда решение A.19) с учетом

формулы разложения определителя A.12) можно записать как

= {х1,х2,х3],

что называют правилом Крамера, которое точно так же формулируется в случае

двух переменных13*.

В качестве упражнения полезно вернуться к представлению решения как

координат вектора Л в базисе, составленном из вектор-столбцов матрицы А.

В двумерном случае

а,\Х\ +Ъхх2 = а,

а2Х\ 4- Ь2х2 = Р,

13)

Равно как и п переменных — см. следующую главу.

28 Глава 1. Аналитическая геометрия

результат получается совсем легко. Векторная запись системы уравнений имеет

вид ах\ 4- Ьх2 = йи после умножения (векторно) на Ь дает (а х Ь)х{ = (д, х Ь)

(поскольку Ь х Ь = 0), откуда х{ = (й х Ь)/(а х &), что есть Х\ =В\1В. Аналогично

получается х2 = #гД>- Деление в данном случае вектора на вектор возможно в

силу коллинеарности векторов.

Переход к другим координатам. Пусть имеется два базиса,

{еье2} и {е'ье^},

и

( [ +812*2,

A-21)

[ +822*2

определяет их взаимосвязь.

Допустим теперь, что ж, обозначают координаты вектора х

в базисе {е}, а х\: — в базисе {е'}. Подставляя е, из A.21) в

х = х\е\ + х2е2 = ж^в! + х*

и приравнивая коэффициенты при ег, — после раскрытия скобок

и приведения подобных, получим

т.е. х = 8*х' и, соответственно, х' — (8*) 1х. Другими словами,

если связь между базисами определяется матрицей 5 — в смыс-

смысле A.21), — то связь между координатами х' = Тх осуществляет

матрица Т = (8*)~{.

Неудобство, связанное с тем, что взаимоотношение базисов

и координат выражается разными матрицами, не играет роли,

поскольку рассматривать то и другое одновременно обычно не тре-

требуется. Пусть, говорят, новые координаты через старые (либо на-

наоборот) выражаются с помощью Т, — и о базисе не вспоминают.

Главное, что Т линейно.

В К3 ситуация аналогична. Выражение одних координат через

другие — это всегда определение проекций вектора

1.6. Прямые и плоскости 29

на новые направления, задаваемые векторами другого базиса. При

этом решает простое правило — проекция суммы векторов равна

сумме проекций:

ге = гх соз (еТж) + гу соз (еру) + тг соз (О)-

Если при переходе к новым координатам растяжения осей не происходит, —

остается только поворот, который описывается матрицей

5(<р)=\СО5<Р

ЧГ/ |51

Транспонированию 5 здесь соответствует замена <р на —<р (замена вращения

на угол (р противоположным вращением),

Упражнение

сов(а + /3) -5Ш (а + /?)] _ Гсоза -эта] Гсоб/З -бш/Л ,?

$т(а + /3) со$(а + /3)\ ~ [зта соз а] " [зтр соз/?] ' ^

1.6. Прямые и плоскости

Различные описания плоскости. Как уравнение

ах + /Зу + 7* + б = О,

т.е. а -г + # = 0, так и

г = Ха + //6 + с,

задают плоскость. Первое описание служит уравнением плоскости

с нормалью а — {а, /?, 7} и позволяет легко проверить, принад-

принадлежит ли предъявляемая точка г = {х, у, г} этой плоскости (про-

(проверкой равенства а - г + д = 0), второе — параметрически задает

плоскость, проходящую через точку с и ортогональную а х Ь, —

с его помощью удобно генерировать точки плоскости, выбирая

произвольно параметры А, /х.

Подобная двойственность характерна для математики вообще, и между та-

такими описаниями иногда лежит пропасть|4). В данном случае различие не так

велико. Из одного описания легко получить другое. (?)

^ См. например, в [3] главу о вычислимости и доказуемости.

30

Глава 1. Аналитическая геометрия

Приведенные варианты являются опорными, но не исчерпы-

исчерпывают возможностей. Необходимо, скажем, описать плоскость, про-

проходящую через три заданные точки

г1 =

г2 = {х2,у2,

г3 = {х3,уз,

Задача выглядит по-другому, но легко сводится к предыдущему.

Полагая, например,

и выбирая в качестве с любую из точек г1, г2, г3, получаем парамет-

параметрическую запись плоскости15) г = \а + цЪ + с. Описанием первого

типа будет

(а х 6) • г + д = 0,

где д определяется подстановкой вместо г любой из точек г1, г2, г3.

В иной форме это можно записать как равенство нулю определителя

Х-

~х\ Уз~У\

-о,

что означает линейную зависимость векторов

Г_Г1, гХ-Г\ Г1-Г\

Кстати, вместо уравнения ах + Ру + 72 + б — 0 часто целесо-

целесообразно использование его эквивалента

а(х -

~ Ч) = 0,

где вместо не всегда удобного параметра 6 фигурирует точка

!Ль 2о}> через которую проходит плоскость.

Прямая. Прямая на плоскости играет роль аналогичную той, кото-

которую играет плоскость в пространстве трех переменных. Поэтому

а(х-хо)+Р(у-уо) = О

' Почему в качестве с можно выбирать любую из точек г\г , г¦ ?

1.6. Прямые и плоскости

31

есть уравнение прямой, ортогональной вектору {а,/?} и проходя-

проходящей через точку {жо, Уо}- Но для описания прямой в пространстве

требуются уже два линейных уравнения

A.22)

Если г удовлетворяет обоим уравнениям, это означает, что г лежит

на пересечении плоскостей, т.е. на прямой.

Разумеется, можно ограничиться одним нелинейным уравне-

уравнением

но это не меняет сути. Суть в каком-то смысле меняет запись A.22)

в виде одного линейного уравнения

г х (а х Ь) = дЪ - (а,

A.23)

однако в координатной записи A.22) — это два уравнения, тогда

как A.23) приводит к трем уравнениям.

Поскольку о происхождении вектора (а х Ь) можно забыть,

каноническое уравнение прямой можно записать так

г х с =

Вектор с здесь направлен вдоль прямой, а д, = г° х с, где г° —

любая точка, через которую проходит прямая.

Другой вариант описания прямой, проходящей через точ-

точку г0, — параметрическое задание, г - г° = ат, т. е.

х - х° = ахт, у-у0 = аут, г - г° = а2т,

где вектор а задает направление прямой.

При необходимости описать прямую, проходящую через две

точки

г1 = {хиуигх}, г2 = {х2, уъ 2г),

32

Глава 1. Аналитическая геометрия

достаточно в качестве а взять вектор г1 - г2. После исключения

параметра г, получается уравнение прямой 16)

X

х2

-х0

-ж,

У

У2

-З/о

-2/1

г

-20

где точка г0 = {х$, уо, %о}-> понятно, не может быть произвольной.

Обычно полагают г° = г] либо г° — г2.

Касательная плоскость. Пусть речь идет о функции двух переменных г = /(ж, у).

Как известно, градиент

дх

д-1\

9 ду)

перпендикулярен к линии постоянного уровня /(ж, у) = сопз1 в любой точ-

точке {ж0, Уо}- Поэтому касательная плоскость — проходящая через точку {ж0, уо} —

к линии постоянного уровня функции

2, — /(ж, у) описывается уравнением

(на рис. 1.14 это пунктирная прямая)

'У

Если интерес представляет каса-

касательная плоскость к поверхности гра-

графика функции г = /(ж, у), то это

сводится к предыдущему случаю рас-

рассмотрением функции и = г - /(ж, у)

трех переменных. Ее градиент

Рис. 1.14 Г д/ 6

\ '~"дх'~~ду.

Поэтому касательная плоскость к поверхности г = /(ж, у) в точке {%о,Хо,уо}

определяется уравнением

1.7. Геометрические задачи

Расстояние до плоскости. Пусть плоскость задает уравнение га = 6.

Если г разложить по взаимно перпендикулярным направлениям

16)

На самом деле — два уравнения.

1.7. Геометрические задачи 33

г = га + г_|_а> становится ясно, что минимальная длина у г будет

в случае г±а = 0. Таким образом, расстояние от начала координат

до плоскости равно

Расстояние от произвольной точки Ь определяется так же — после

переноса в Ь начала координат, что достигается заменой г = г' + Ь,

и в итоге дает величину \6 - а • 6|/||а||.

Если требуется не само минимальное расстояние, а ближайшая к началу

координат точка (на плоскости), то для ее определения надо решить систему

из двух векторных уравнений: га = 6игха = 0, что равносильно г1о = 0.

При нежелании иметь дело с векторами — можно рассматривать координат-

координатную запись задачи:

х2 + у2 + г2 -> ппп, ах + /Зу + ^г = 6,

которая легко решается методом множителей Лагранжа (см. [4, т. 1]).

Расстояние до прямой. Разнообразие возможностей здесь опреде-

определяется вариантами задания прямой, которые легко сводятся друг

к другу. В варианте A.23), т.е. г х а = с, ближайшая к началу

координат точка на прямой определяется системой уравнений

г х а — с, г • а = 0.

Находя решение и вычисляя длину соответствующего вектора г,

получаем расстояние до прямой (от начала координат).

Если сама ближайшая точка не нужна, то расстояние определя-

определяется совсем просто. Раскладывая г по взаимно перпендикулярным

направлениям г — г\\а + г±а, в ближайшей к началу координат точке

имеем |гха| * 11а11 = НСН> откуда искомое расстояние:

1И1/И1

Скрещивающиеся прямые. Пусть имеются две прямые, описываемые уравнениями

г х а = А, з х Ь = В,

где векторы г и з лежат, соответственно, на первой и второй прямой.

Умножая первое уравнение скалярно на 6, второе — на а, имеем

(г х а) • Ъ = А • 6, (« х Ъ) • а = В • а,

34 Глава 1. Аналитическая геометрия

или равносильно 17)

г-(ахЬ) = А-Ь, з • (Ь х а) = В • а.

Последние два уравнения при сложении дают

(г - 5) • (а х Ъ) = А - Ъ + В • а.

Это означает, что проекция вектора г — 5 на направление (а х Ь) постоянна.

Поэтому длина (норма) г - в будет минимальна, когда (г — з) || (а х 6). В этом

случае \\г - з\\ • \\а х 6|| = ||А • Ъ + В • а\\, откуда (минимальное) расстояние между

прямыми равно

\\А-Ъ + В-а\\

\\а х *|| '

При А • Ь + В • а = 0 прямые пересекаются.

Чтобы найти сами точки г и 5, на которых достигается минимум расстояния,

надо решить систему трех векторных уравнений

(г - 5) х (а х Ъ) = 0, г ха = А, з хЪ = В.

Частные задачи.

• В ряде случаев полезна следующая формула для двойного век-

векторного произведения18)

а х (Ь х с) = Ь(а • с) - с(а • 6).

Вот одно из полезных следствий:

п х (Ь хп) = Ь- п(п • Ь), если п-п= 1,

что приводит к формуле

Ь = п(п -Ъ) + п х (Ъ хп), \\п\\ = 1,

которая дает разложение Ь на две составляющие — параллель-

параллельную и перпендикулярную единичному вектору п.

• Координатно-векторное мышление «переворачивает» и упро-

упрощает почти любую геометрическую задачу. Вот, например, как

выглядит векторное доказательство известного факта: если диа-

диагонали четырехугольника АВСБ делят друг друга пополам, то

АВСБ — параллелограмм.

Поскольку смешанное произведение а • (Ь х с) не меняется при циклической переста-

перестановке векторов (и меняет знак при — не циклической) — объем параллелепипеда тот же

самый, знак определяет ориентация.

18^ Мнемоническое правило: «абэцэ равно бац минус цаб».

1.8. Кривые и поверхности второго порядка 35

Пусть а,Ь,с,й — радиус-векторы, соответственно, вершин

А, В, С, И. По условию

(а + с)=(Ь + а),

откуда следует Ь - а = с - й, т. е. стороны АВ и СВ равны

и параллельны. >

Упражнения

• Пусть а,Ь,с — радиус-векторы вершин треугольника АВС. Тогда вектор

з = ахЬ + ах с + Ьхс

равен удвоенной площади ААВС и перпендикулярен плоскости, в которой

лежит треугольник.

• Уравнение

ХоХ + УоУ + 202 — К2

определяет плоскость, касающуюся сферы х2+у2+г1—К2 в точке {х0, у0, г0}.

• Пусть а,Ь,с — радиус-векторы вершин треугольника АВС. Тогда радиус-

вектор точки пересечения биссектрис равен

_ аВС + ЬАС + сАВ

Т~~ ВС + АС + АВ '

где ВС, АС, АВ — длины соответствующих сторон,

а + Ъ + с

г = — точка пересечения медиан,

г — — точка пересечения высот.

\%А + \%В + \%С

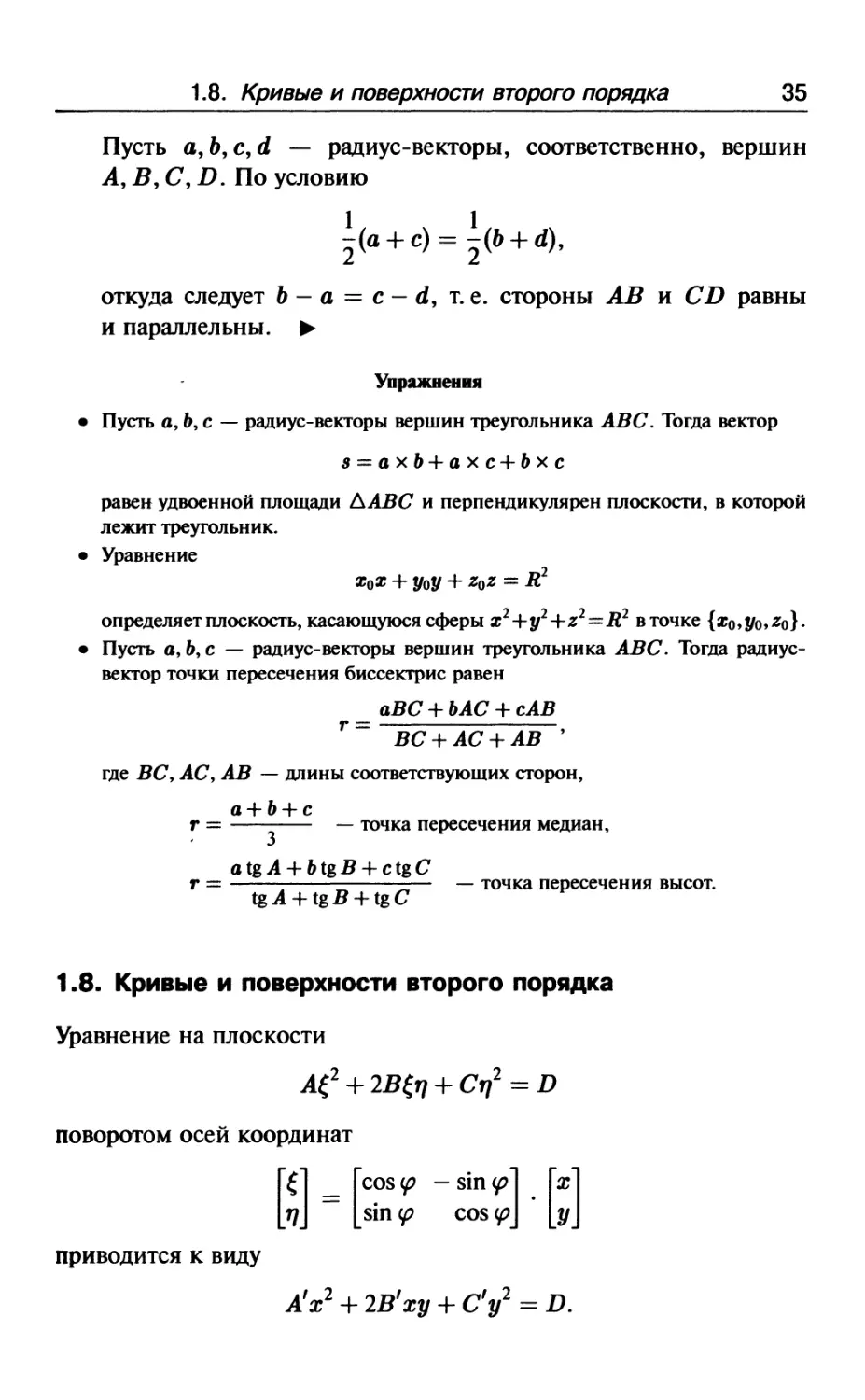

1.8. Кривые и поверхности второго порядка

Уравнение на плоскости

поворотом осей координат

_ Гсо8 V ~ 8*п чЛ Гж1

приводится к виду

А!х2 4- 2В'ху 4- С1 у1 = В.

36

Глава 1. Аналитическая геометрия

При этом выбором угла <р всегда можно обеспечить19) В' = 0. Вари-

Варианты в результате считаются на пальцах одной руки. Вырожденные

случаи, когда одна из констант Аг, С' обращается в нуль20), мало-

малоинтересны. В остающихся вариантах получаются эллипс и гипербола.

Эллипс. Каноническое уравнение эллипса:

а > Ь > 0.

На рис. 1.15 изображена со-

соответствующая геометрическая

фигура. Величины а и Ь равны

длинам большой и малой полу-

полуосей. В случае а = Ь получается

окружность.

-Ь

Рис.1-15. Эллипс

Эллипс обладает радом замеча-

замечательных свойств и может быть охарак-

охарактеризован как:

• Множество точек плоскости, для каждой из которых сумма расстояний

до фокусов Р\, Р2 постоянна и равна 2а. Расстояние между фокусами — 2с,

гдес2 = а2-Ь2.

• Кривая, получаемая в пересечении кругового конуса с плоскостью.

Оптическое свойство: световой луч, исходящий из одного фокуса, после

отражения от эллипса проходит через другой фокус.

Отношение е = с/а называют эксцентриситетом эллипса. В полярных

координатах р, <р эллипс описывается уравнением

1 + е сов (р'

где р — фокальный параметр, равный половине длины вертикальной хорды,

проходящей через фокус.

Принять на веру или проверить — каждый решает сам. Хорошо (плохо) и то, и другое.

Проверки изощряют навыки, но замедляют ход. Вера, как воздушный шар, быстро возносит

в облака, но отрывает от Земли.

20)

Это соответствует ситуации

1.8. Кривые и поверхности второго порядка

37

Пространственное обобщение — эллипсоид. Уравнение:

а2 + Ь2 + с2

Птербола. Гипербола — плоская кривая,

как и эллипс, представляет собой сечение конуса плоскостью.

На рис. 1.16 изображена соответствующая геометрическая фигу-

а

ра. Имеет две асимптоты у = ±—х. Расстояние между фокусами Р\,

о

Р2 — 2с, где с2 = а2 + Ь2.

Характеризуется как геометриче-

геометрическое множество точек плоскости, мо-

модуль разности расстояний которых до Р\

и 2*2 постоянен и равен 2а.

При а = Ь асимптоты взаимно

перпендикулярны. Если их принять за

координатные оси, — уравнение гипер-

гиперболы трансформируется в у = к/х.

)

а

/

Ь

ч

( *

Пространственное обобщение —

гиперболоид. Уравнение:

Рис. 1.16. Гипербола

Глава 2

Векторы и матрицы

2.1. Примеры линейных задач

Изучать абстрактную науку удобнее, имея в голове несколько содержательных

задач. Конечно, преодолевать отвращение к конкретике нелегко, но это потом

окупается.

Модель производства. Пусть ж; обозначает интенсивность ^'-го технологического

процесса, а|; — количество 1-го продукта, производимого (а|; > 0) или потреб-

потребляемого (а|; < 0) при единичной интенсивности ,;-го технологического процесса.

Суммарное производство (потребление) 1-го продукта определяется суммой

п

У,- = 53вуЖу, 1=1,..., т. B.1)

;='

На этом фоне могут решаться задачи оптимизации типа ^Г^ с^ -> шах.

1

Межотраслевой баланс. Имеется п отраслей, 1-я отрасль выпускает 1-й продукт

в количестве ж,. На выпуск единицы 1-го продукта в системе затрачивается а^ ^ 0

единиц ^-то продукта. Понятно, что при выпуске набора

х = {х19...,хп}

чистый выпуск 1-го продукта равен

Вопрос о продуктивности модели, таким образом, сводится к положительной

разрешимости системы уравнений ^

*' =

!' Толи при любом, то ли при некотором наборе у > 0. Как оказывается, существование

продуктивного плана х > 0 при некотором у > 0 достаточно для существования решения

х ^ 0 — при любом у^О.

2.2. Векторы 39

Транспортная задача. Допустим, имеется п пунктов, в которых производится

и потребляется некий вид продукта (хлеб, например). Из г-го пункта в ^'-й

продукт перевозится в количестве ж,;. Естественно, что из г-го пункта нельзя

вывезти больше продукта, чем там производится: \^ ж,; ^ Р,, а в ^'-й пункт надо

завозить не меньше, чем там потребляется \^ ж,; ^ С;.

I

Если цена перевозки единицы продукта из г-го пункта в ;-й — равна Л1;,

общая задача минимизации транспортных расходов выглядит так:

Пассажиропотоки. В городе имеется п районов, Р, — число жителей г-го района,

IV] — число работающих в ^'-м районе, наконец, ж,; — число живущих в г-м

районе и работающих в ^'-м. Очевидно,

К этим линейным взаимосвязям переменных могут добавляться другие фак-

факторы и соотношения.

2.2. Векторы

При изучении вектор-функций /(х\,..., хп) набор х = {х\ч...,хп}

называют вектором, мысленно откладывая значения х\,...,хп

по координатным осям «выдуманного» пространства.

Аналогия с обычным представлением о векторах становится

осмысленной при подходящем определении операций:

• умножение на скаляр А ,

Хх = {Ажь...,Ажп}, B.2)

• сложение,

х + у = {х\ + 2/1,..., хп + уп), B.3)

• скалярное произведение,

х-у = Хху1 + ... + хпуп, B.4)

для которого используются эквивалентные обозначения2) (х, у)

и ху.

^ Эквивалентные обозначения не менее ценная вещь, чем синонимы в обычном языке.

40

Глава 2. Векторы и матрицы

С помощью скалярного произведения вводится норма (длина

вектора),

11x11 = \/ж2 =

которую принято считать евклидовой.

Множество векторов, на которых введены перечисленные операции,

называют п-мерным евклидовым пространством и обозначают Кп.

Операции B.2)—B.4) представляют собой обобщения ана-

аналогичных понятий в Е3. Покоординатное сложение B.3) в К3

равносильно определению суммы векторов по правилу параллело-

параллелограмма. Скалярное произведение в К3 изначально иногда опре-

определяется как произведение длин векторов на косинус угла между

ними, но потом выясняется, что формула B.4) при п = 3 дает то же

самое. В общем случае такая интерпретация может быть сохранена

благодаря известному неравенству Коши—Буняковского3)

М1-Ы1,

B.5)

которое дает возможность ввести понятие косинуса угла между

векторами при любом п,

B.6)

-4 Неравенство B.5) доказывается совсем просто. Раскрывая скобки в оче-

очевидном неравенстве (х — ХуJ ^ 0, имеем

для любого Л, — что возможно лишь при неположительности дискриминанта

квадратного многочлена — а это и есть B.5). >

' Альтернативное название: неравенство Коши—Шварца.

2.2. Векторы

41

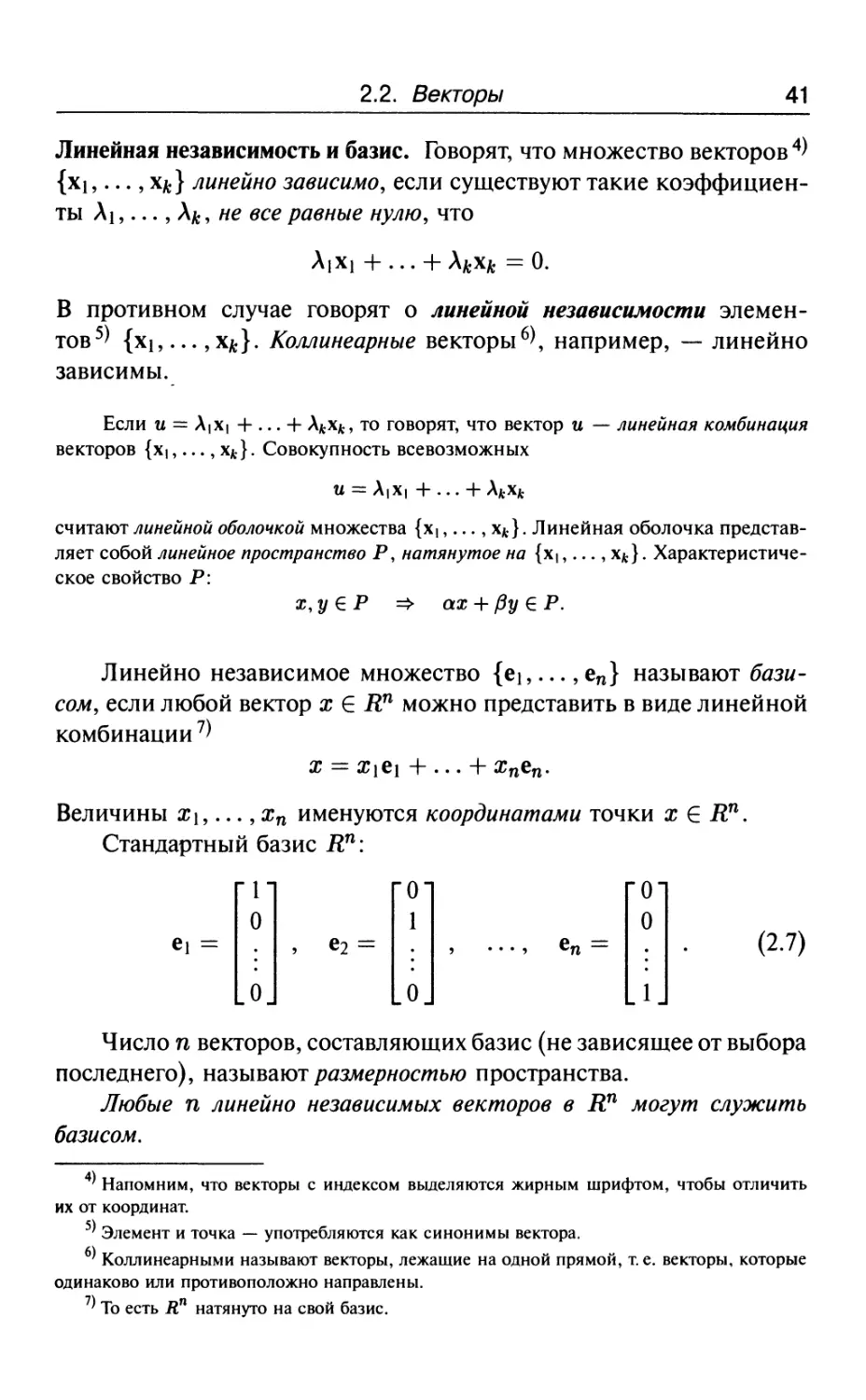

Линейная независимость и базис. Говорят, что множество векторов 4)

{хь ..., х#} линейно зависимо, если существуют такие коэффициен-

коэффициенты А1,..., А*, не все равные нулю, что

В противном случае говорят о линейной независимости элемен-

элементов5) {хь... , х*}. Коллинеарные векторы6), например, — линейно

зависимы.

Если и = Х\Х\ + ... + А*хл, то говорят, что вектор и — линейная комбинация

векторов {х!,..., хк}. Совокупность всевозможных

и = Х\Х\ + ... + Хкхк

считают линейной оболочкой множества {Х(,..., х*}. Линейная оболочка представ-

представляет собой линейное пространство Р, натянутое на {хь ..., х*}. Характеристиче-

Характеристическое свойство Р:

х.уеР =» ах + /Зу€Р.

Линейно независимое множество {еь ..., еп} называют бази-

базисом, если любой вектор х Е Кп можно представить в виде линейной

комбинации7)

х = х{е\ + ... + жпеп.

Величины Х\,..., хп именуются координатами точки х Е Яп.

Стандартный базис Кп:

B.7)

Число п векторов, составляющих базис (не зависящее от выбора

последнего), называют размерностью пространства.

Любые п линейно независимых векторов в Кп могут служить

базисом.

' Напомним, что векторы с индексом выделяются жирным шрифтом, чтобы отличить

их от координат.

' Элемент и точка — употребляются как синонимы вектора.

6^ Коллинеарными называют векторы, лежащие на одной прямой, т. е. векторы, которые

одинаково или противоположно направлены.

' То есть Яп натянуто на свой базис.

42

Глава 2. Векторы и матрицы

Упражнения

• Если множество векторов {Гь ..., Гш} составляет базис Кп, то га = п.

Множество

"Г

0

1

1

0

Г, =

является базисом в множестве векторов вида

Ортогональность. Векторы х, у определяют как ортогональные, если

их скалярное произведение равно нулю, х • у — 0.

Важная роль ортогональности заключена в том, что с ее помо-

помощью определяется понятие плоскости Ро, как множества элемен-

элементов х, ортогональных некоторому вектору а,

= 0, т.е. а\Х\

апхп = 0.

Понятно, что х,у б Ра влечет за собой ах + /Зу Е Ра-

Описанная стартовая позиция представляет собой упрощенный взгляд

на предмет — достаточный для понимания основных результатов

линейной алгебры при некотором поэтапном расширении угла зрения.

Важно лишь отдавать себе отчет в ограниченности избранного ра-

ракурса, чтобы для необходимых дополнений были открыты «форточки».

Вот некоторые бреши в изложении, которые будут заделаны позже. Нера-

Неравенство Коши—Буняковского гарантирует сов \р ^ 1, но этого мало для определе-

определения угла.

Правда, сама формула B.6) далее не требуется, но она полезна в идеологиче-

идеологическом отношении — ибо легализация п-мерного пространства в сфере подсознания

нуждается в том, чтобы Кп имело те же атрибуты, что и К3. Обоснование B.6)

тривиально. Два вектора ж, у определяют плоскость Р (проходящую через три

точки 0, ж, у), представляющую собой двумерное пространство К2, — а скалярное

произведение х • у в К2 как раз и дает косинус. Таким образом, при любой

размерности Кп угол остается явлением двумерным, что льет воду на мельницу

«легализации».

Однако легко сказка сказывается. На указанном пути возникает проблема

с толкованием х • у в плоскости Р. Беда в том, что в основе определения B.4)

2.3. Распознавание образов 43

лежит координатное представление8* векторов. При переходе к другой системе

координат скалярное произведение как-то меняется (по форме записи) — пока

не ясно как. В плоскости Р система координат вообще не задана. Как ее

задать, и нужно ли? Благодаря двумерности Р, можно просто ограничиться

произведением длин векторов на косинус угла между ними. Но совпадет ли это

с результатом перемножения по формуле B.4)?

Имеется также некоторое ощущение дискомфорта в связи с понятиями

ортогональности, базиса и размерности. Пока есть пробелы в определении угла,

ортогональность слегка расплывается. Как понимать х • у = 0? Лучше всего, как

сов (рху = 0, но это уже сказка про белого бычка.

На упомянутые вопросы легко ответить, особенно, если начинать с более

точных определений абстрактного характера (см. раздел 3.5). В данном случае

избран не самый экономный путь для того, чтобы лучше почувствовать мотиви-

мотивировку некоторых абстракций, освоение которых помогает геометрическому стилю

мышления. Линейную алгебру, строго говоря, можно изучать вообще без геомет-

геометрических представлений, как науку о прямоугольных таблицах чисел, с- но тогда

она больше походит на китайскую грамоту. Здесь предпочтение отдается ее трак-

трактовке как теории линейных операторов, действующих в евклидовом пространстве.

Это требует некоторых дополнительных усилий на освоение исходных понятий,

что окупается впоследствии наглядностью и другими удобствами.

2.3. Распознавание образов

Абстрактные высоты хороши при обеспеченных тылах. Поэтому время от вре-

времени имеет смысл возвращаться к практическим задачам, которые напоминают

о секторе прицела.

В одной из возможных постановок задачи распознавания образов объекты

характеризуются наборами параметров х = {х\,... ,хп} и группируются в классы

(образы), которым в Кп соответствуют некоторые множества точек.

Допустим, есть всего два класса объектов 9) и, соответственно, два множества

РЬР2 6 -й", которые для простоты будем считать конечными. Предположим, что

существует плоскость, разделяющая Рх и Р2. Это означает существование такого

вектора с, что сх > О, если х 6 Р\, и сх < О, если х 6 Рг-

В процессе обучения линейной распознающей машине предъявляется бес-

бесконечная обучающая последовательность

в которой любой объект из Р\ или Р2 встречается бесконечное число раз.

Машина в качестве с принимает сначала произвольный вектор с0, и потом меняет

8' Уступки в общности определений обычно выигрывают в наглядности, но проигрывают

в широте охвата.

9) Скажем, жук и бегемот, либо А и В, либо свой самолет и самолет противника.

= ск-хк

44 Глава 2. Векторы и матрицы

его следующим образом. Если с помощью с* точка хк распознается правильно, то

с*+1 =с*. Если же хк ЕР\у но с* ж* ^ 0, то с**1 = с* + хк .И

если хк € Рг, но с*ж* ^ 0. Вопрос заключается в том, научится ли машина

за конечное число шагов безошибочно распознавать образы.

Многословие описания здесь связано с содержательной интерпретацией.

Грамотный математический эквивалент выглядит проще. Существование разделя-

разделяющей плоскости равносильно наличию такого вектора с, что

сх > 0 для любого х е Р = Р\ р| (-Рг).

Процедура подстройки с*:

Г с*, если с*ж* > 0,

с Ч * * * * ВСе Х еР' A8)

с +х ,

если

^ Покажем сходимость B.8) за конечное число шагов. Пусть хк обозначает

сокращенную обучающую последовательность, из которой выброшены правильно

распознаваемые «показы». Тогда

сН1=1Ч... + 1*, B.9)

если для простоты положить с0 = 0. Умножая B.9) на с, получаем

ск+1 -с = х1 с + ... + хкс^к0,

где в > 0 — минимальное значение х • с при условии х Е Р.

Опираясь далее на неравенство Коши—Буняковского, приходим к оценке

Н^'И^р*. BЛ0)

С другой стороны, возводя с7 = с*; +1? в квадрат, имеем

что, в силу (? -х}^0, дает Н^"'!!2 - Цс^Ц2 ^ ||ж;||2. Суммируя эти неравенства по ],

приходим к

А:

^Ч2 *+|^ B.11)

где в — максимум Ця^'Н при условии х Е Р.

Сопоставление неравенств B.11) и B.10) показывает, что к не может расти

неограниченно. >

2.4. Линейные отображения и матрицы

45

2.4. Линейные отображения и матрицы

Линейная функция

у = пх =

апхп

принимает постоянные значения а • х — C на «плоскостях» парал-

параллельных плоскости а• х = 0. Действительно, из а • и = /?, а • г; = /?

следует а • (и - г;) = 0, т. е. вектор и - V параллелен (лежит в)

плоскости а • х = 0.

Множества ах — C называют гиперплоскостями1^, чтобы

подчеркнуть, что они не являются линейными пространствами,

которым положено вместе с векторами содержать их сумму. Другими

словами, гиперплоскость — это плоскость, не проходящая через

начало координат.

Важную роль в анализе играет понятие линейного оператора,

сопоставляющего вектору х = {х\,..., хп} вектор у = {у\,..., уп}

по правилу:

Ух =

Уг =

B.12)

Уп = Оп\Х\ + ап2х2 + ... + аппхп.

Таблицу коэффициентов А = [а^],

А =

ап а12 •-. ащ

а2\ а22 ... а2п

аП[ ап2 ... апп

называют матрицей, и коротко пишут у — Ах, определяя тем самым

умножение матрицы на вектор.

Из приведенной записи видно, что первый индекс у а,; обозначает номер

строки, второй — столбца. Совокупность элементов Оц,..., апп называют главной

диагональю матрицы.

10)

А иногда — и просто плоскостями, допуская вольность терминологии.

46

Глава 2. Векторы и матрицы

Через аг: обозначается г-я строка матрицы А, через а^ — ]-й

столбец, т. е.

Двоеточие как бы заменяет весь список индексов.

Матрица называется невырожденной, если ее вектор-строки

линейно независимы.

Забегая вперед, отметим, что из линейной независимости вектор-строк выте-

вытекает линейная независимость вектор-столбцов, которую с равным успехом можно

было бы взять за определение невырожденной матрицы.

Умножение матрицы на скаляр 7 и сложение матриц А — [ау]

иВ = [6у] определяются так:

7Л = [7ау], А + В = [ау + &,,].

При этом, очевидно,

А(\х + /гу) = ХАх + /хАу.

Умножение А на В дает матрицу С = АВ с элементами

B.13)

Иными словами, су оказывается равным скалярному произведению

1-й вектор-строки а|: на ]-й вектор-столбец Ь^, т.е.

Полезно также представление

B.14)

2.4. Линейные отображения и матрицы

47

которое подчеркивает, что ] -й столбец матрицы С = АВ получается

умножением ]-то столбца матрицы В на матрицу А, Соотношение

B.14) означает

ап

+

т. е. каждый столбец матрицы С представляет собой линейную

комбинацию столбцов А. Все это, конечно, тавтология, не при-

прибавляющая содержания. Но такая перезапись B.13) меняет форму

восприятия и помогает укрупненно мыслить.

Правило умножения матриц возникает автоматически, если

на матрицы смотреть как на линейные операторы. Вектор х под

действием оператора В переходит в г = Вх, а вектор г под дей-

действием оператора А переходит в у = Ах. Результирующее преоб-

преобразование х в у определяется матрицей С = АВ с элементами с^,

формула вычисления которых B.13) определяется обыкновенным

приведением подобных,

Уг =

Произведение матриц в общем случае не коммутативно

АВфВА

, но ассоциативно

А(ВС) = (АВ)С

и дистрибутивно

А(В + С) = АВ +

«/то лег/со проверяется.

В случае АВ = В А говорят, что матрицы А и В коммутируют.

Матрица А* с элементами а* = а^ называется транспониро-

транспонированной к А, и получается как бы пространственным поворотом А

вокруг главной диагонали на 180°, в результате чего столбцы и стро-

строки меняются местами. Матрицу называют симметричной (симмет-

(симметрической), если А = А*, и — кососимметричной, если А — — А*.

48

Глава 2. Векторы и матрицы

Для транспонированной матрицы широко распространены обозначения

А' либо АТ, тогда как через А* обозначают сопряженную мат-

матрицу, которая получается из А транспонированием с последующим

комплексным сопряжением всех элементов о,;. Например,

Г г 3 ГГ-г 2 + .1

[2-г 1 + г] ~ [ 3 1 - г] *

Таким образом, в случае матриц с вещественными элементами, како-

каковые пока имеются в виду, сопряженная матрица А* — есть транспо-

транспонированная. Поэтому использование обозначения А* экономит символы

«штрих» и «Т» для других целей.

При транспонировании произведения часто используется фор-

формула

(АВ)*=В*А*.

B.15)

Л Доказательство занимает одну строчку,

(АВУ =

Ъаи=В'А'. >

Обратной к А называют матрицу А ', такую что

где / — единичная матрица и\

1 0 ... О

О 1 ... О

О 0 ... 1

определяющая тождественное преобразование 1х = х. Очевидно,

1А = А1 = А

для любой матрицы А.

И)

Иногда используют обозначение / = (Пае {1,..., 1}.

2.5. Прямоугольные и клеточные матрицы

49

Вопрос существования обратной матрицы рассматривается да-

далее. Пока речь идет об определении, но уже из определения вытека-

вытекают некоторые следствия. В частности, формула, аналогичная B.15),

B.16)

при условии, что матрицы А и В обратимы.

А После умножения B.16) слева на В получается В(АВ) ' = А ', что

после умножения слева на А переходит в очевидное АВ(АВ)~Х = /. Разумеется,

эта цепочка обладает доказательностью в обратном направлении. Очевидное

АВ(АВ)~Х — I после умножения слева на Л, потом на В~х, — дает B.16J)

12)

Транспонируя А х А — 1, получаем А*(А ])* = I,

откуда

что означает перестановочность операций транспонирования и об-

обращения матрицы.

2.5. Прямоугольные и клеточные матрицы

Матрицу А, имеющую т строк и п столбцов, называют тхп мат-

матрицей. При переходе от квадратных матриц к прямоугольным кое-

что теряет смысл, но многое — сохраняется. С некоторыми уточ-

уточнениями, конечно. Например, произведение С = АВ вычисляется

по той же формуле B.13), но теперь при условии, что число столб-

столбцов А равно числу строк В. В противном случае АВ не имеет смысла.

Понятие прямоугольной матрицы позволяет считать векторы

тоже матрицами. При этом надо следить, какую «матрицу» представ-

представляет собой вектор — вектор-столбец или вектор-строку. Чтобы мат-

матрицу А умножать на х справа, надо, чтобы х был обязательно век-

вектор-столбцом. После транспонирования вектор-столбца возможно

х*А. Скалярное произведение (х, у) записывают тогда в виде х*у.

1 ' Обычно мы стараемся не засорять текст подобными уточнениями. Концентрация

на идейной стороне дела требует жертв.

50

Глава 2. Векторы и матрицы

Для наглядности:

Ух

х{уп

При этом важно не увлекаться общностью, чтобы не потерять

различие между векторами и матрицами, которое позволяет считать

векторы точками пространства, а матрицы — линейными опера-

операторами. Возможность подобной интерпретации составляет главную

силу линейной алгебры.

Заметим, наконец, что у — Ах в случае прямоугольной т х п

матрицы А можно интерпретировать как линейное преобразова-

преобразование ш-мерного вектора х в п-мерный вектор у. Понимать это

можно по-разному. Векторы х, у могут принадлежать совершенно

разным пространствам, не имеющим друг к другу никакого отно-

отношения, а могут — быть векторами одного и того же «объемлющего»

пространства. Но это связано не с природой задачи, а с волей,

как говорят, лица, принимающего решение13). Придание того или

иного смысла координатам

{«!,..., жте}, {уь...,уп}

будет порождать различные геометрические интерпретации, предо-

предоставляя или упраздняя те или иные возможности.

Ортогональна, например, система координат в записи вектора

х = {х\,..., хт} или нет? Годится любой ответ. На усмотрение «за-

«заказчика». До поры до времени можно обходиться даже без ответа.

Но если возникает, скажем, необходимость в скалярном произве-

произведении, то без декларации свойств системы координат уже не обой-

обойтись 14\ Ортогональная — тогда скалярное произведение определя-

определяется формулой B.4), нет — тогда нужна другая формула (см. далее).

Другое дело, что разумная воля опирается на понимание задачи и действует в интересах

эффективного решения.

' На практике часто обходятся без явных деклараций. Какая система координат имеется

в виду — вытекает из контекста.

2.6. Два примера

51

Блочное умножение. Матрицы могут состоять из прямоугольных

блоков,

А =

А\к

В\\

В2\

В\8

#41 #42 •••

где каждая из клеток А^, В^ представляет собой прямоугольную

матрицу. Если размеры клеток согласованы, а именно: А^ имеет

размер т, х п;, а В^ — щ х г;, то матрицы А и В можно умножать

прямо в блочном виде по «обычному» правилу

где блоки Си получаются размера га, хг/,и они образуют матрицу

Если А и В квадратные матрицы, то

С

,_\А В]

-[В -А\

АВ-ВА\

-АВ

2.6. Два примера

Матрицей перестановки называют матрицу, у которюй в каждом столбце и каждой

строке — ровно один элемент равен 1, остальные нули. Умножение на такую

Матрицу слева — переставляет строки, справа — столбцы. Например,

Матрицы перестановок, вообще говоря, не коммутируют, но их произведение

остается матрицей перестановки.

У треугольных матриц ненулевые элементы стоят исключительно выше

(ниже) главной диагонали:

*„ 1|2 ...

О 122 ...

О ... О

*21 «22

52 Глава 2. Векторы и матрицы

В первом случае матрицу называют верхней треугольной, во втором — нижней.

Произведение треугольных матриц одного типа — есть треугольная матрица того же

типа. Обратная к треугольной {если существует) — тоже треугольная матрица

(соответственно, верхняя или нижняя).

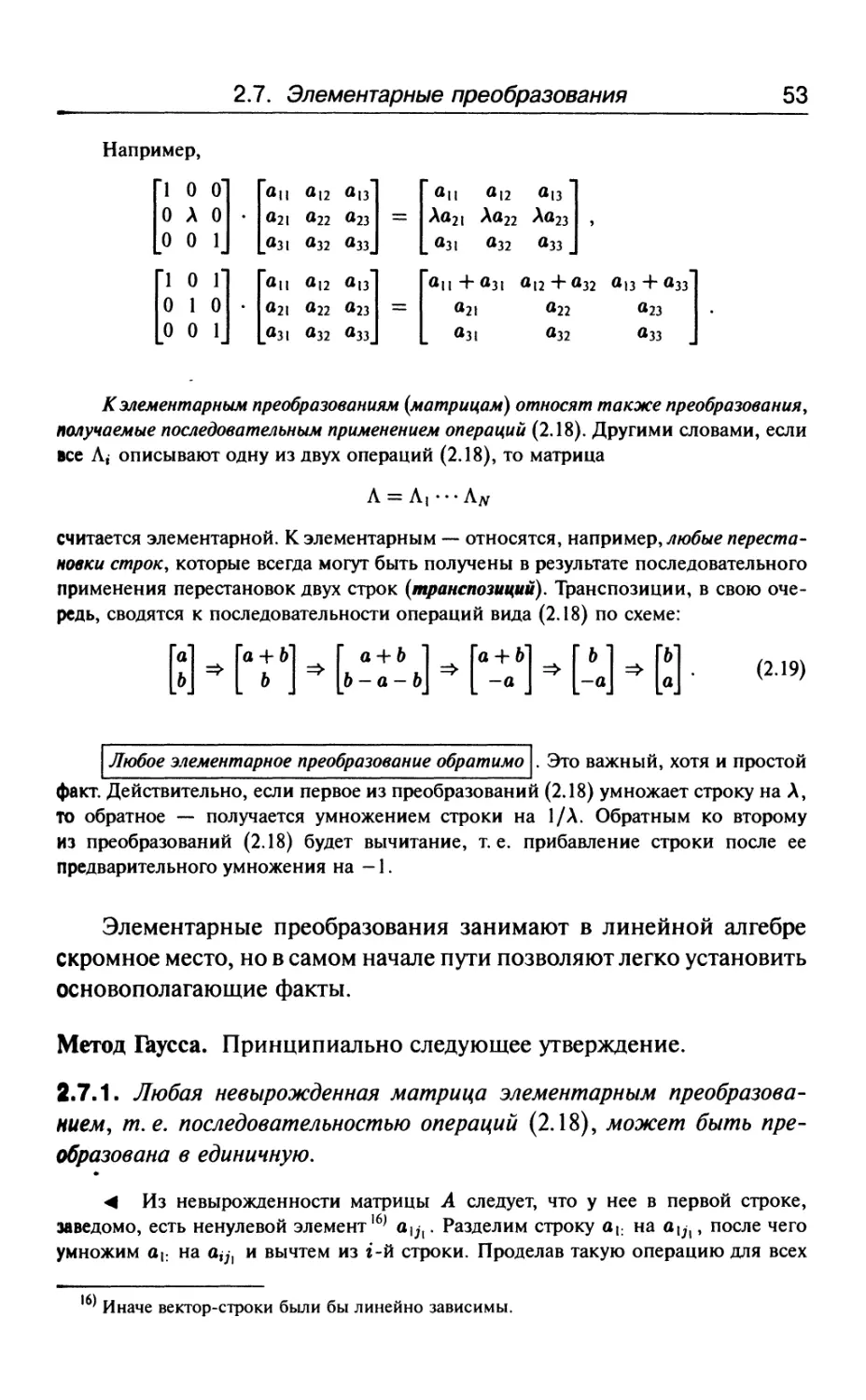

2.7. Элементарные преобразования

На B.12) можно смотреть как на систему линейных уравнений

относительно ж. Решение этой системы иногда воспринимают как

главную задачу линейной алгебры, но такая расстановка акцентов

ошибочна. Сама по себе задача решения системы

а,,ж,

п = у2, .

к ап1ж, + оп2х2 + ... + аппхп = уп

достаточно тривиальна, хотя без нюансов ни одно простое дело,

конечно, не обходится.

Один из возможных способов решения системы B.17) мог бы опираться

на последовательное применение всего двух операций:

• умножение любого выбранного уравнения на ненулевой скаляр;

• сложение двух уравнений.

Если при этом отвлечься от уравнений и следить за матрицей

то указанным операциям соответствуют два элементарных преобразования мат-

матрицы:

умножение строки матрицы на ненулевой скаляр; . .

прибавление одной строки к другой, — У • )

каждому из которых можно сопоставить умножение А слева на некоторую эле-

элементарную матрицу Л. В первом случае Л получается из единичной матрицы /

заменой г-й единицы на диагонали скаляром Л ф 0. Во втором случае Л получа-

получается из единичной матрицы / заменой нуля, стоящего на пересечении г-й строки

и 2 -го столбца, — единицей 15).

1 ' Если речь идет о прибавлении г-й строки к ^'-й.

2.7. Элементарные преобразования 53

Например,

П О П Г0П «12 <*1з] [ОП+ОЗ! «12 +«32 «13 + <*3з]

О 1 0 • 021 О22 °23 = «21 О22 «23

И) О 1 I |031 О32 «33 I I «31 «32 «33 I

К элементарным преобразованиям (матрицам) относят также преобразования,

получаемые последовательным применением операций B.18). Другими словами, если

все Л, описывают одну из двух операций B.18), то матрица

Л = Л, •••Л#

считается элементарной. К элементарным — относятся, например, любые переста-

перестановки строк, которые всегда могут быть получены в результате последовательного

применения перестановок двух строк (транспозиций). Транспозиции, в свою оче-

очередь, сводятся к последовательности операций вида B.18) по схеме:

Любое элементарное преобразование обратимо . Это важный, хотя и простой

факт. Действительно, если первое из преобразований B.18) умножает строку на Л,

То обратное — получается умножением строки на 1/Л. Обратным ко второму

из преобразований B.18) будет вычитание, т.е. прибавление строки после ее

предварительного умножения на -1.

Элементарные преобразования занимают в линейной алгебре

скромное место, но в самом начале пути позволяют легко установить

основополагающие факты.

Метод Гаусса. Принципиально следующее утверждение.

2.7.1. Любая невырожденная матрица элементарным преобразова-

преобразованием, т.е. последовательностью операций B.18), может быть пре-

преобразована в единичную.

<4 Из невырожденности матрицы А следует, что у нее в первой строке,

заведомо, есть ненулевой элемент]6) а];1. Разделим строку п\: на й|;,, после чего

умножим 01; на о^;, и вычтем из 1-й строки. Проделав такую операцию для всех

Иначе вектор-строки были бы линейно зависимы.

54 Глава 2. Векторы и матрицы

г = 2,..., п, получим в итоге матрицу Апею, у которой в $\ -м столбце стоят везде

нули, за исключением а^, = I.

Матрица А™" невырождена |7\ поэтому во второй строке у нее есть ненулевой

элемент а™* • Далее, по аналогии с предыдущим, делим строку а™ на а™*, затем

умножаем вновь полученную строку на а™* и вычитаем из 1-й строки. Проделав

это для всех г ф 2, получим в итоге матрицу, у которой в ]2 -м столбце стоят

везде нули, за исключением а2,2 = 1. Заметим, что в результате второго этапа

преобразования $\ -и столбец, остается прежним (везде нули, за исключением 1

на {1, ]\} -м месте).

Продолжая далее в том же духе, в конце концов получим матрицу, у которой

в каждой строке и в каждом столбце всего одна единица — остальные нули. Такая

матрица перестановкой строк легко преобразуется в единичную18). >