Текст

probabilités

2

master

agrégation

Jean-Yves Ouvrard

CASSINI

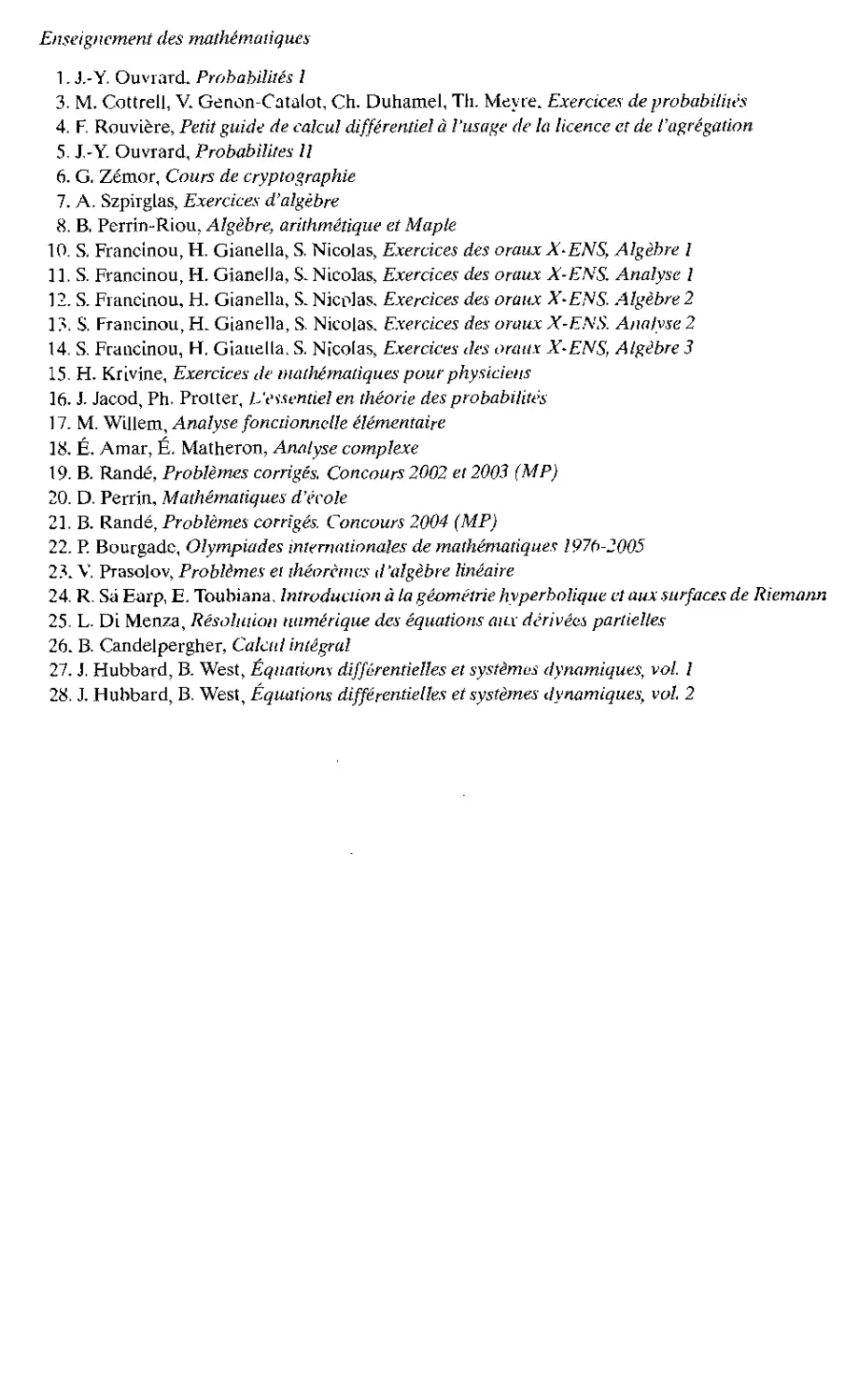

Enseignement des mathématiques

1. J.-Y. Ouvrard. Probabilités 1

3. M. Cottrell, V. Genon-Catalot, Ch. Duhamel, Th. Meyre. Exercices de probabilités

4. F. Rouvière, Petit guide de calcul différentiel à l'usage de la licence et de l'agrégation

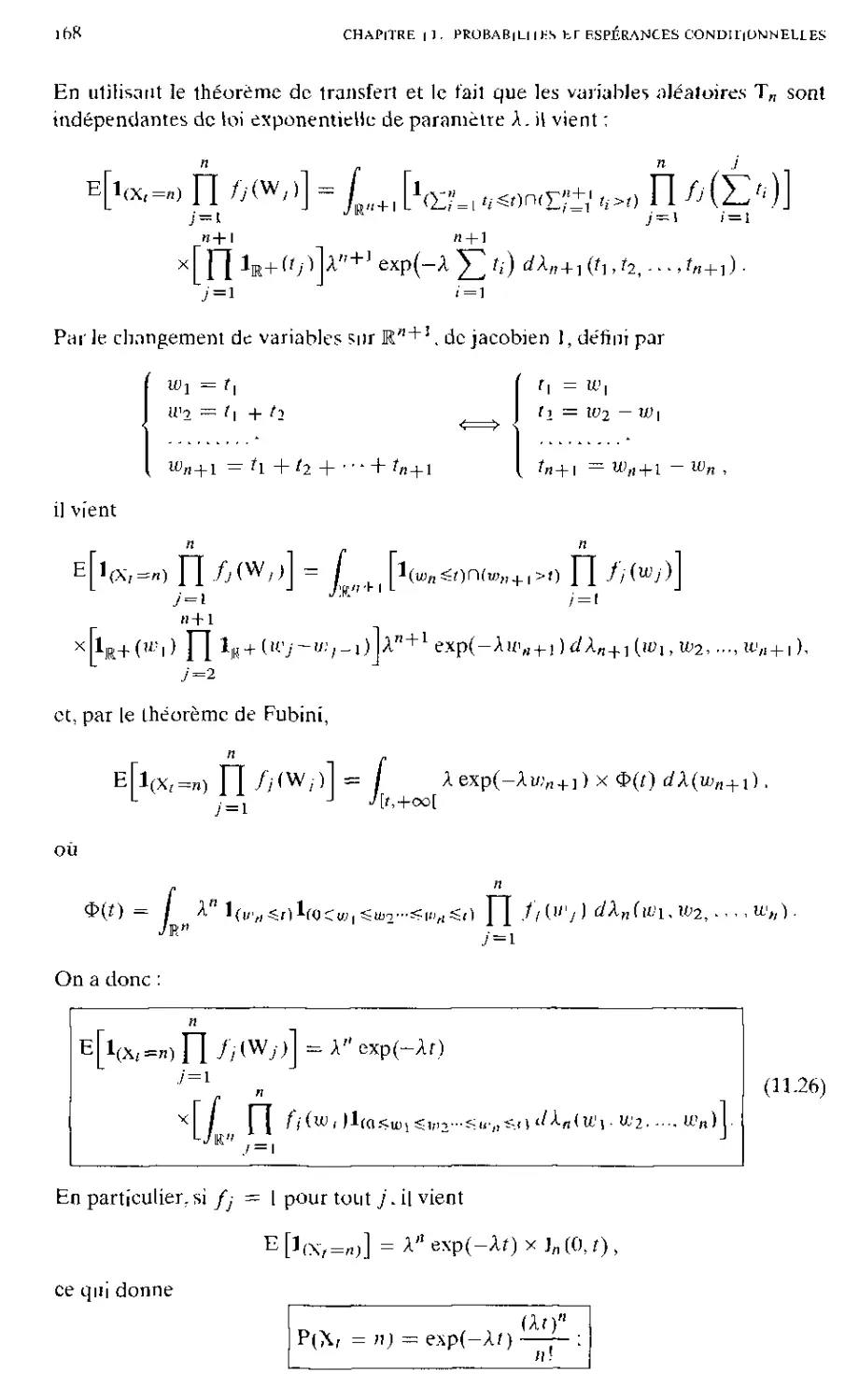

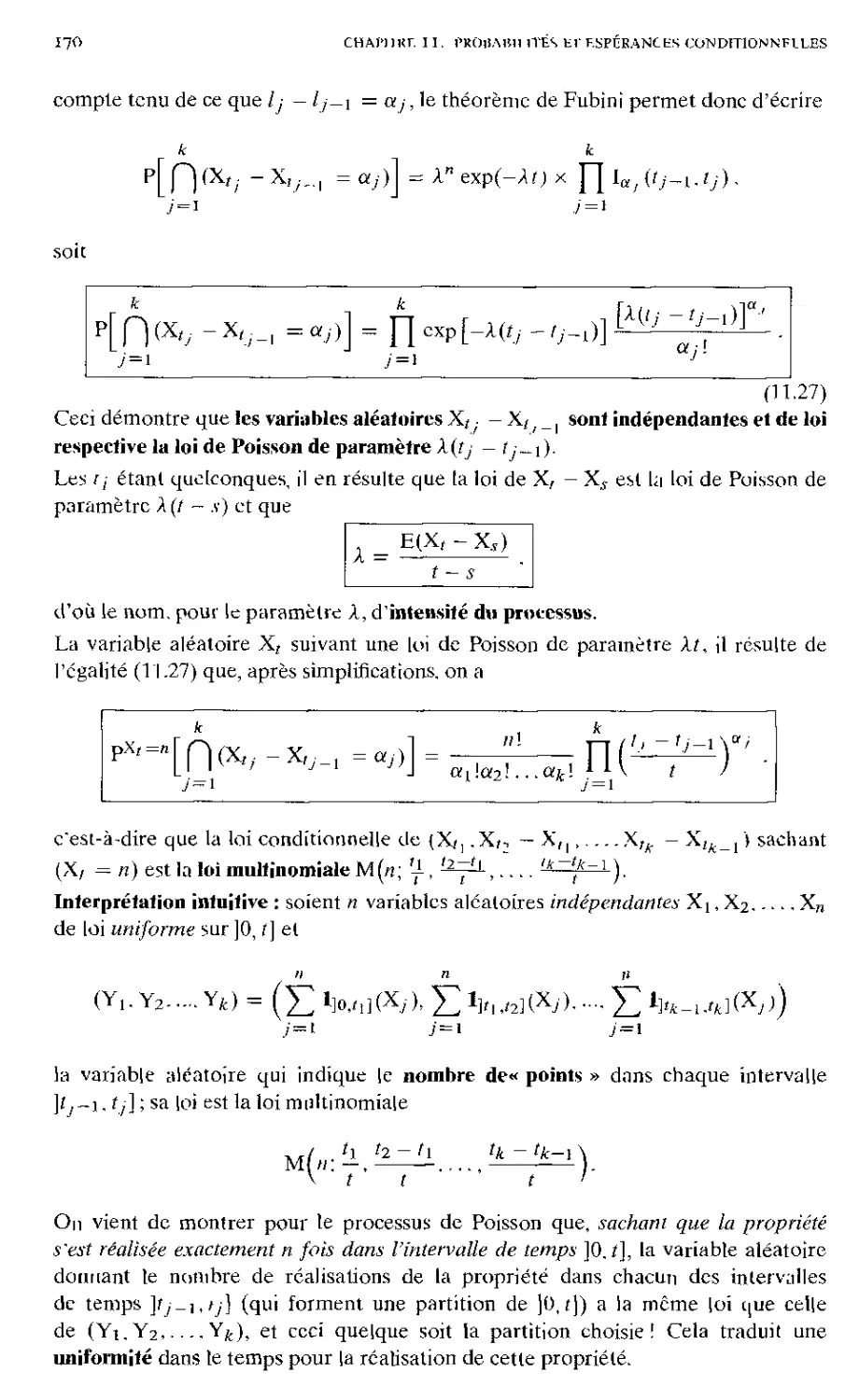

5. J.-Y. Ouvrard, Probabilités II

6. G. Zémor, Cours de cryptographie

7. A. Szpirglas, Exercices d'algèbre

8. B. Perrin-Riou, Algèbre, arithmétique et Maple

10. S. Francinou, H. Gianella, S. Nicolas, Exercices des oraux X-ENS, Algèbre !

ILS. Francinou, H. Gianella, S. Nicolas, Exercices des oraux X-ENS. Analyse !

12. S. Francinou, H. Gianella, S. Nicolas. Exercices des oraux X-ENS. Algèbre 2

1 ?, S. Francinou, H. Gianella, S. Nicolas. Exercices des oraux X-ENS. Analyse 2

14. S. Francinou, H. Gianella, S. Nicolas, Exercices des oraux X-ENS, Algèbre 3

15. H. Krivine, Exercices de mathématiques pour physiciens

16. J. Jacod, Ph. Prolter, L'essentiel en théorie des probabilités

17. M. Willem, Analyse foncnonnclle élémentaire

18. É. Amar, É. Matheron, Analyse complexe

19. B. Randé, Problèmes corrigés. Concours 2002 et 2003 (MP)

20. D. Perrin, Mathématiques d'école

21. B. Randé, Problèmes corrigés. Concours 2004 (MP)

22. P. Bourgade, Olympiades internationales de mathématiques 1970-2005

2?. V, Prasolov, Problèmes et théorèmes d'algèbre linéaire

24. R. Sa Earp, E. Toubiana, Introduction à ta géométrie hyperbolique cl aux surfaces de Riemann

25. L. Di Menza, Résolution numérique des équations aiLY dérivées partielles

26. B. Candelpergher, Calcul intégral

27. J, Hubbard, B. West, Éqiiaiioni différentielles et systèmes dynamiques, vol. I

28. J. Hubbard, B. West, Équations différentielles et systèmes dynamiques, vol. 2

JEAN-YVES OUVRARD

Probabilités

TOME II

Master — Agrégation

CASSINI

Jean-Yves Ouvrard est maître de conférences à l'Université Joseph Fourier de

Grenoble. Il est docteur d'État en mathématiques.

Troisième édition, 2009

ISBN 978-2-84225-144-4

© Cassini, Paris, 2000.

Premier*; édition (2000) ISBN 2-84225-010-9,

deuxième édition corrigée (2004) ISBN 2-84225-086-7

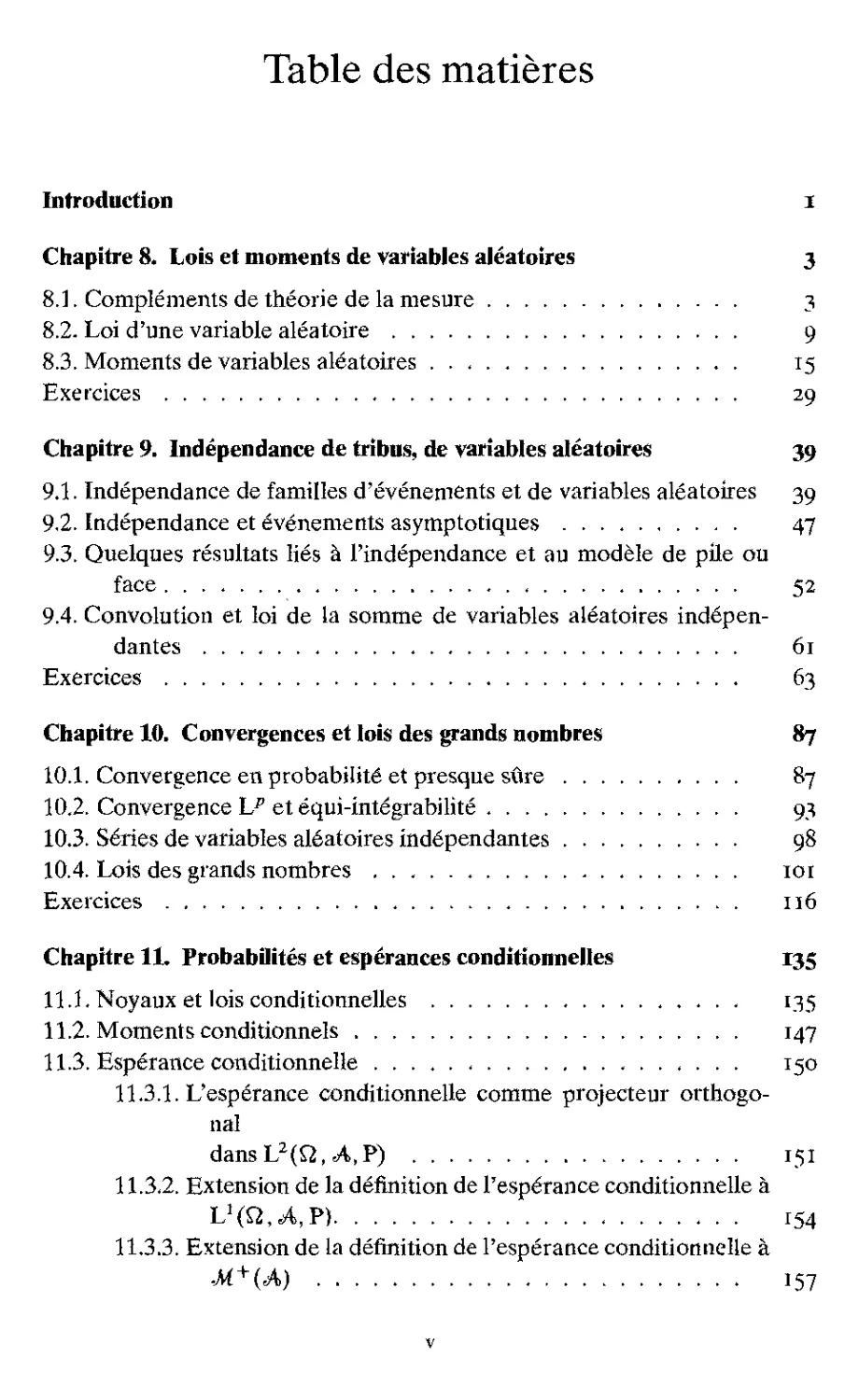

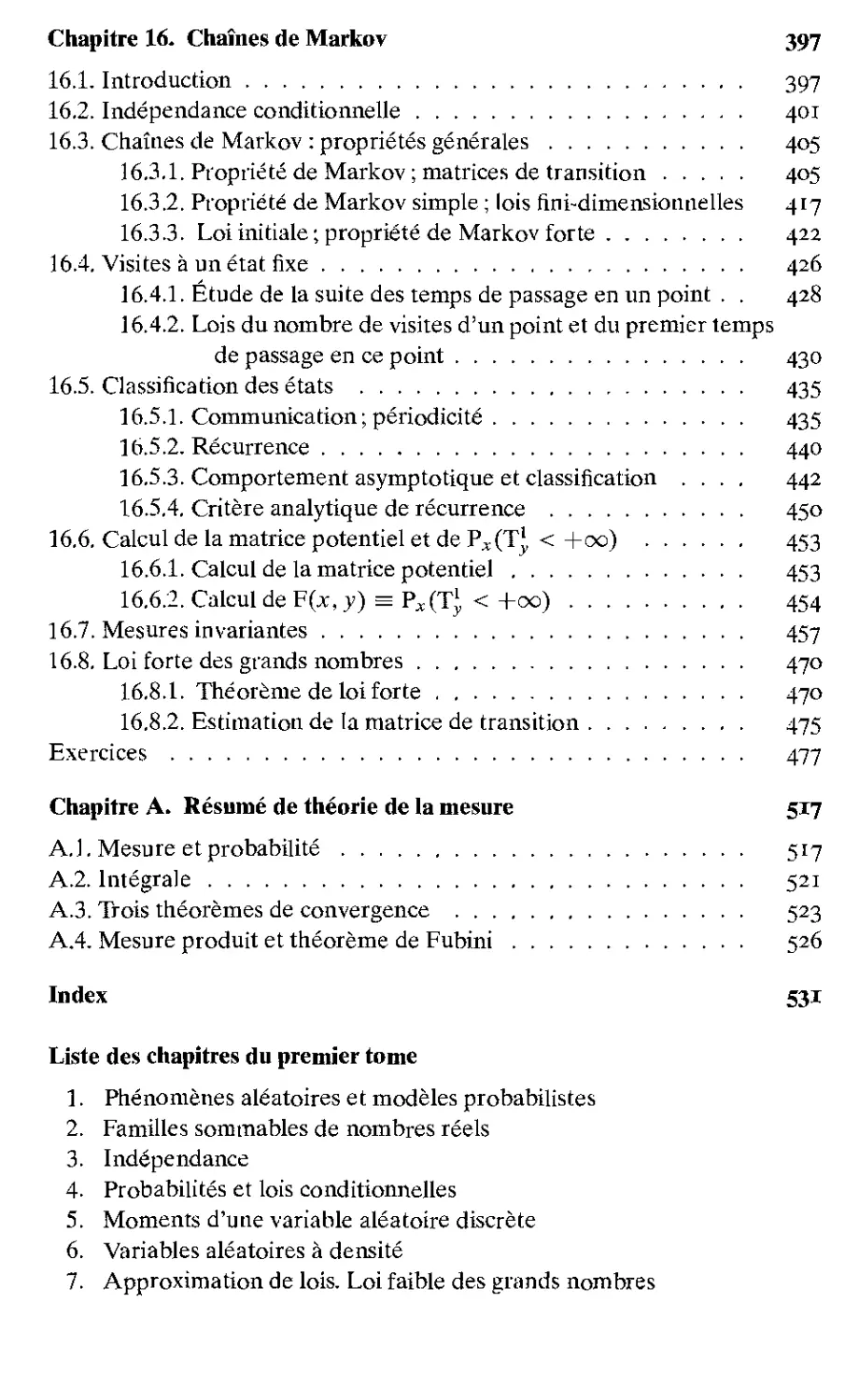

Table des matières

Introduction I

Chapitre 8. Lois et moments de variables aléatoires 3

8.1. Compléments de théorie de la mesure 3

8.2. Loi d'une variable aléatoire 9

8.3. Moments de variables aléatoires 15

Exercices 29

Chapitre 9. Indépendance de tribus, de variables aléatoires 39

9.1. Indépendance de familles d'événements et de variables aléatoires 39

9.2. indépendance et événements asymptoriques 47

9.3. Quelques résultats liés à l'indépendance et au modèle de pile ou

face 52

9.4. Convolution et loi de la somme de variables aléatoires

indépendantes 61

Exercices 63

Chapitre 10. Convergences et lois des grands nombres 87

10.1. Convergence en probabilité et presque sûre 87

10.2. Convergence hp et équi-intégrabilité 93

10.3. Séries de variables aléatoires indépendantes 98

10.4. Lois des grands nombres 101

Exercices 116

Chapitre 11. Probabilités et espérances conditionnelles 135

11.1. Noyaux et lois conditionnelles 135

11.2. Moments conditionnels 147

11.3. Espérance conditionnelle 150

11.3.1. L'espérance conditionnelle comme projecteur

orthogonal

dansL2(Q,-A,P) 151

11.3.2. Extension de la définition de l'espérance conditionnelle à

L1 (Q, A, P) 154

11.3.3. Extension de la définition de l'espérance conditionnelle à

¦M + (A) 157

v

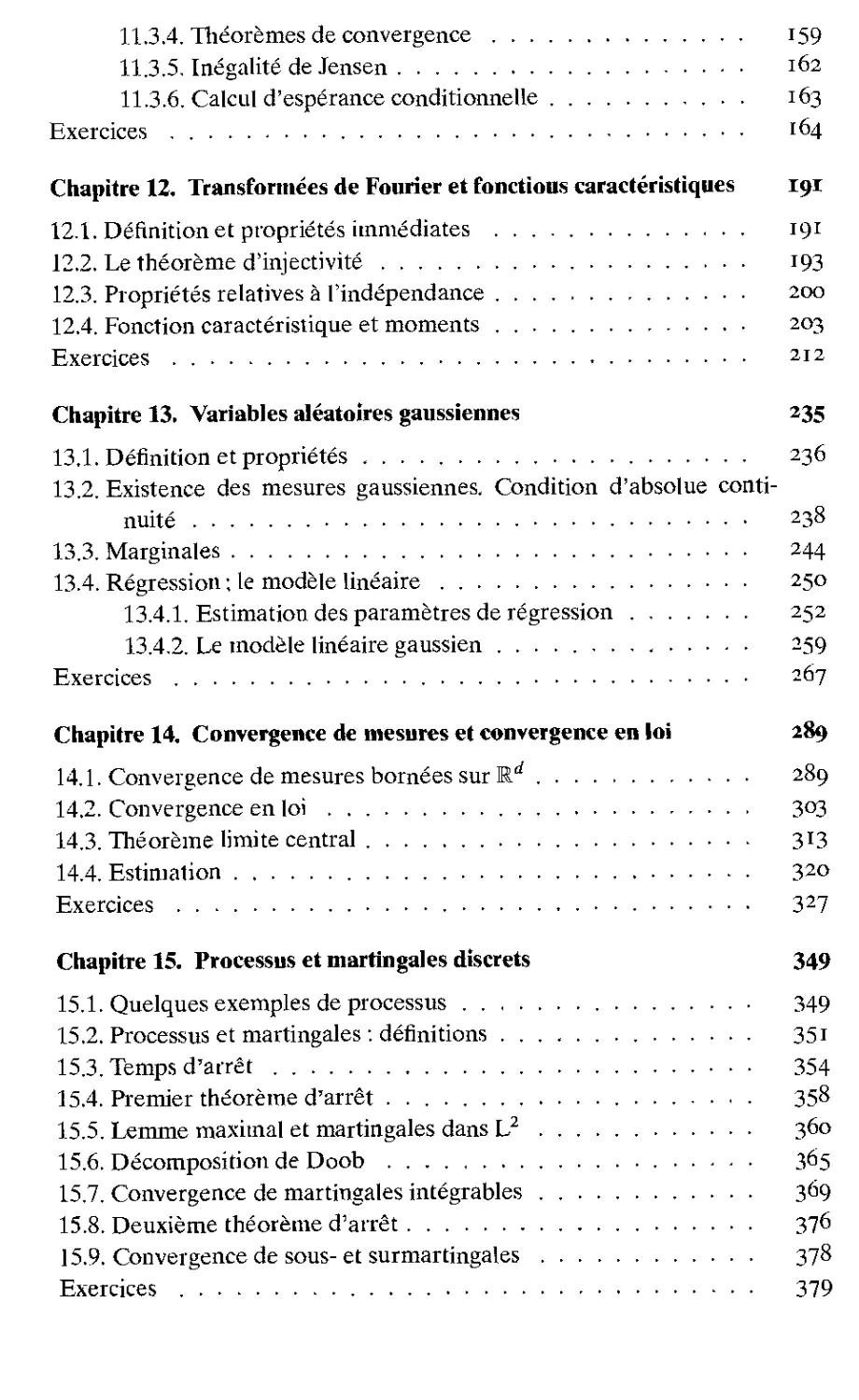

11.3.4. Théorèmes de convergence 159

11.3.5. Inégalité de Jensen 162

11.3.6. Calcul d'espérance conditionnelle . 163

Exercices . 164

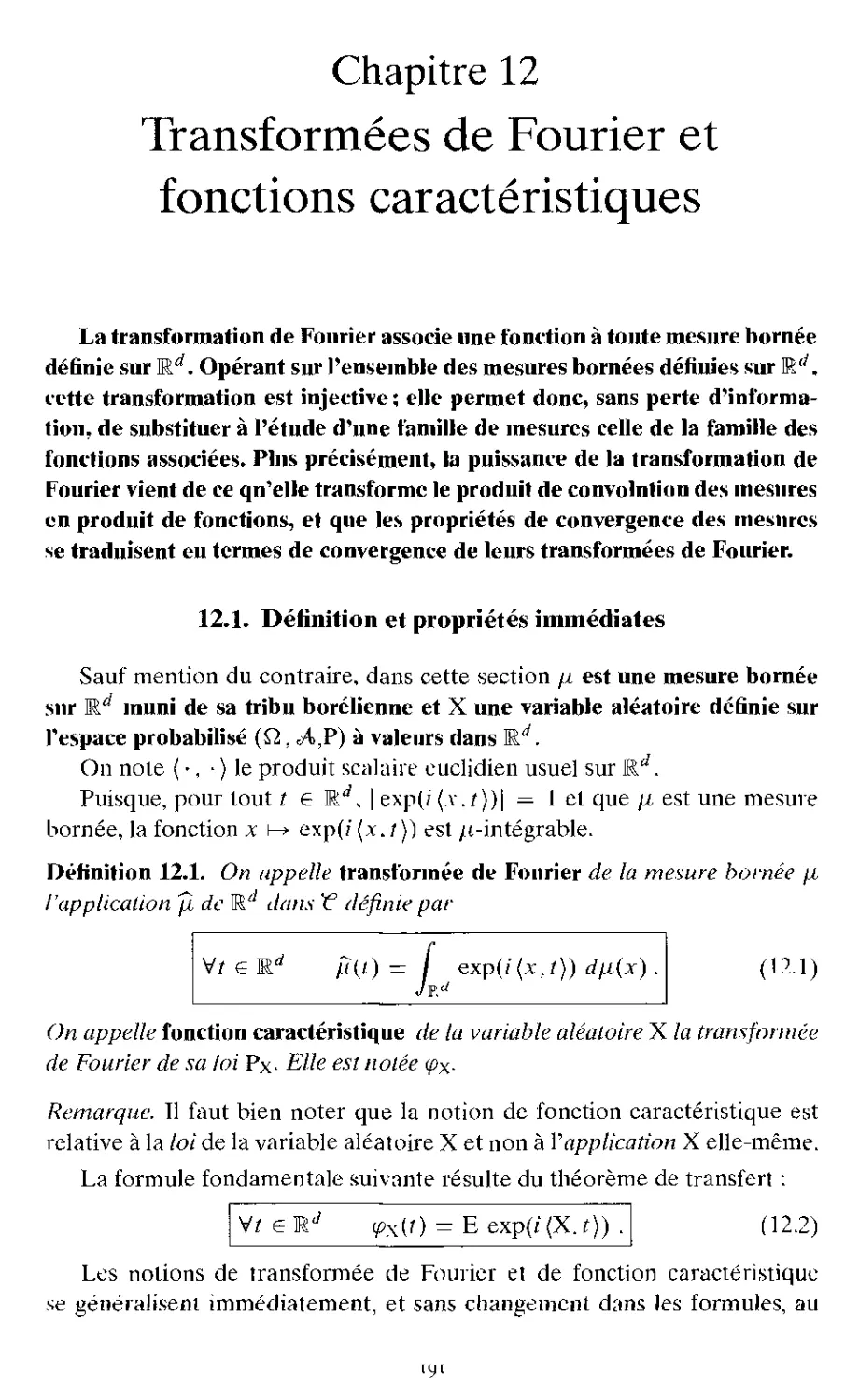

Chapitre 12. Transformées de Fourier et fonctious caractéristiques 191

12.1. Définition et propriétés immédiates 191

12.2. Le théorème d'injectivité 193

12.3. Propriétés relatives à l'indépendance 200

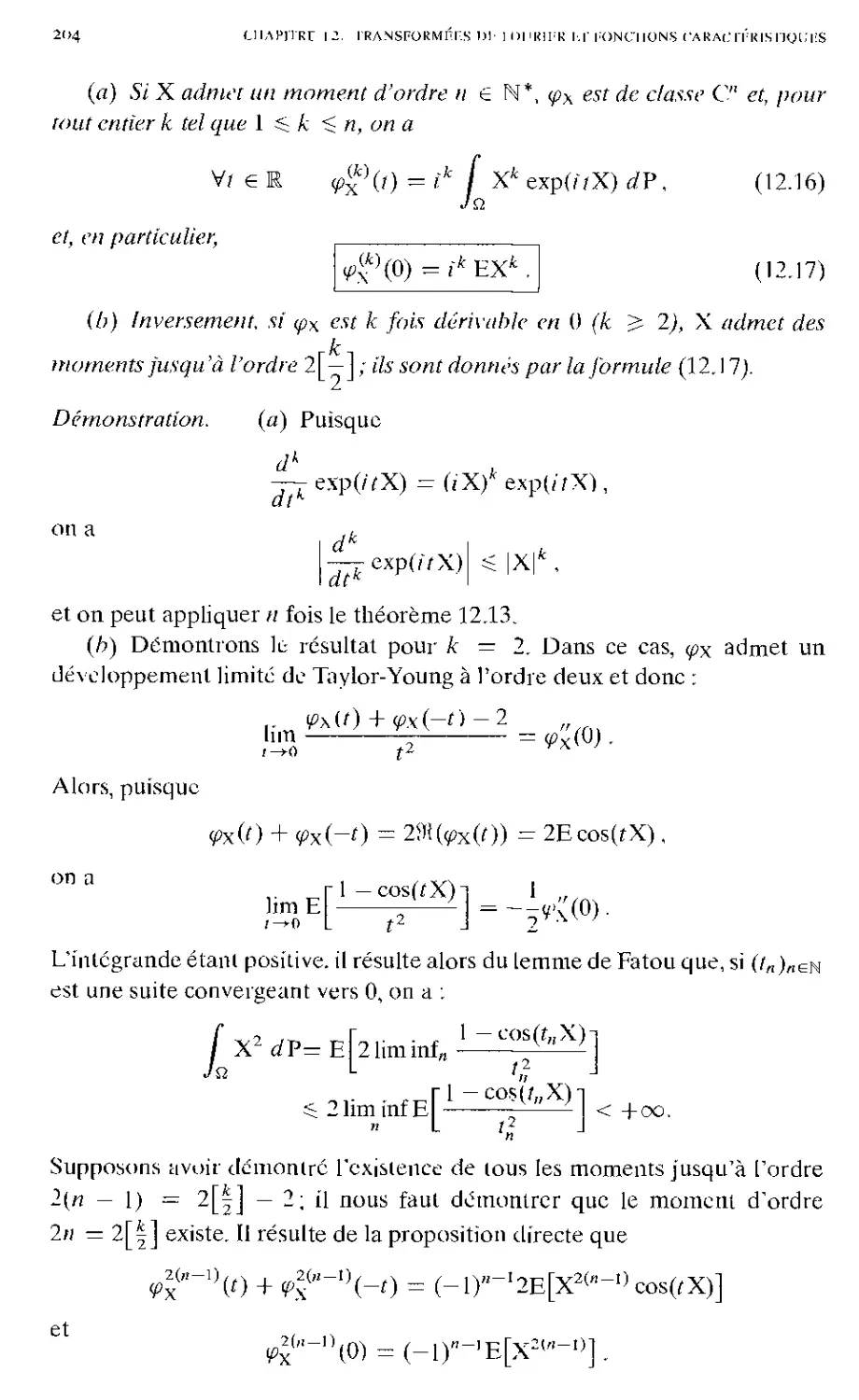

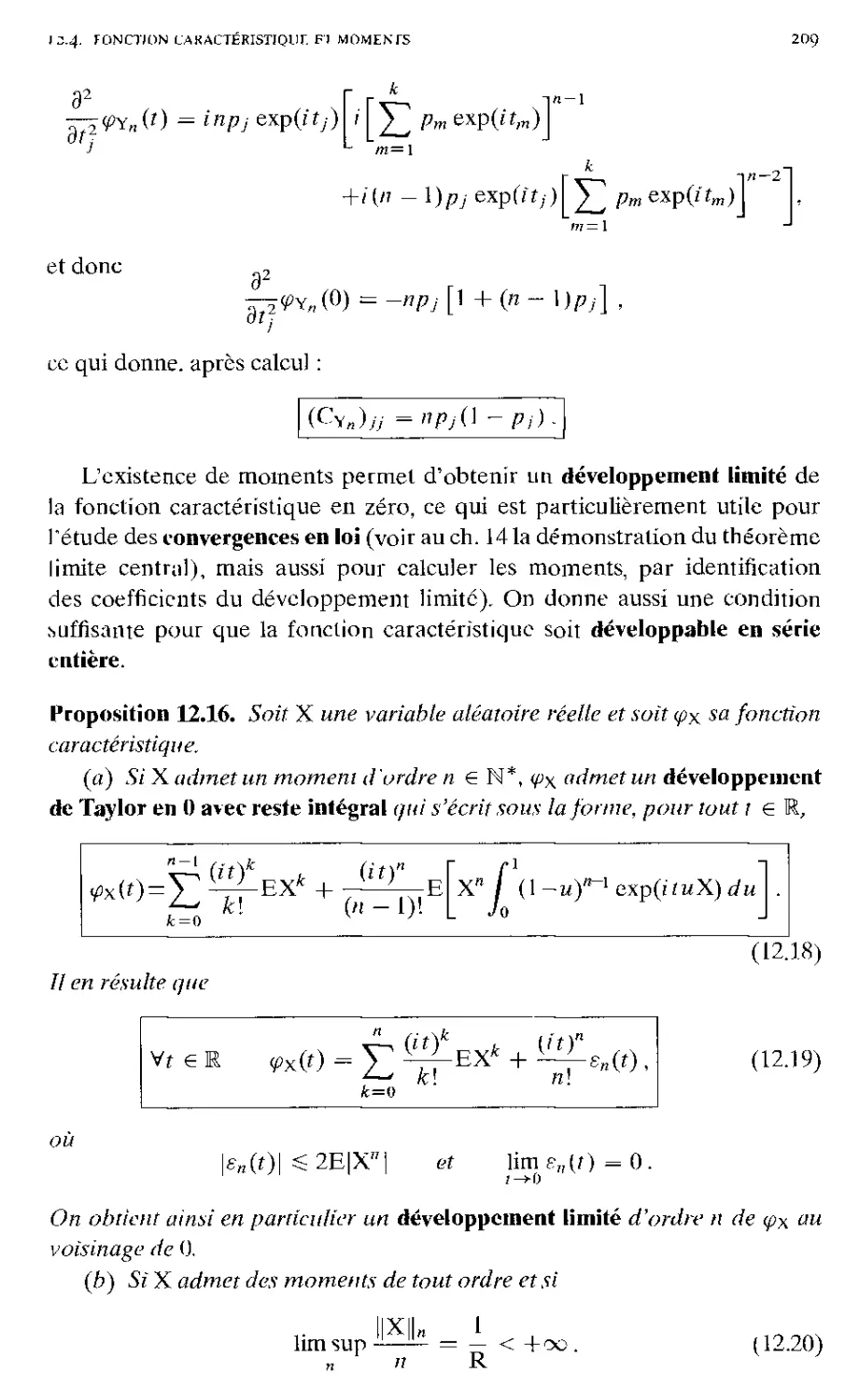

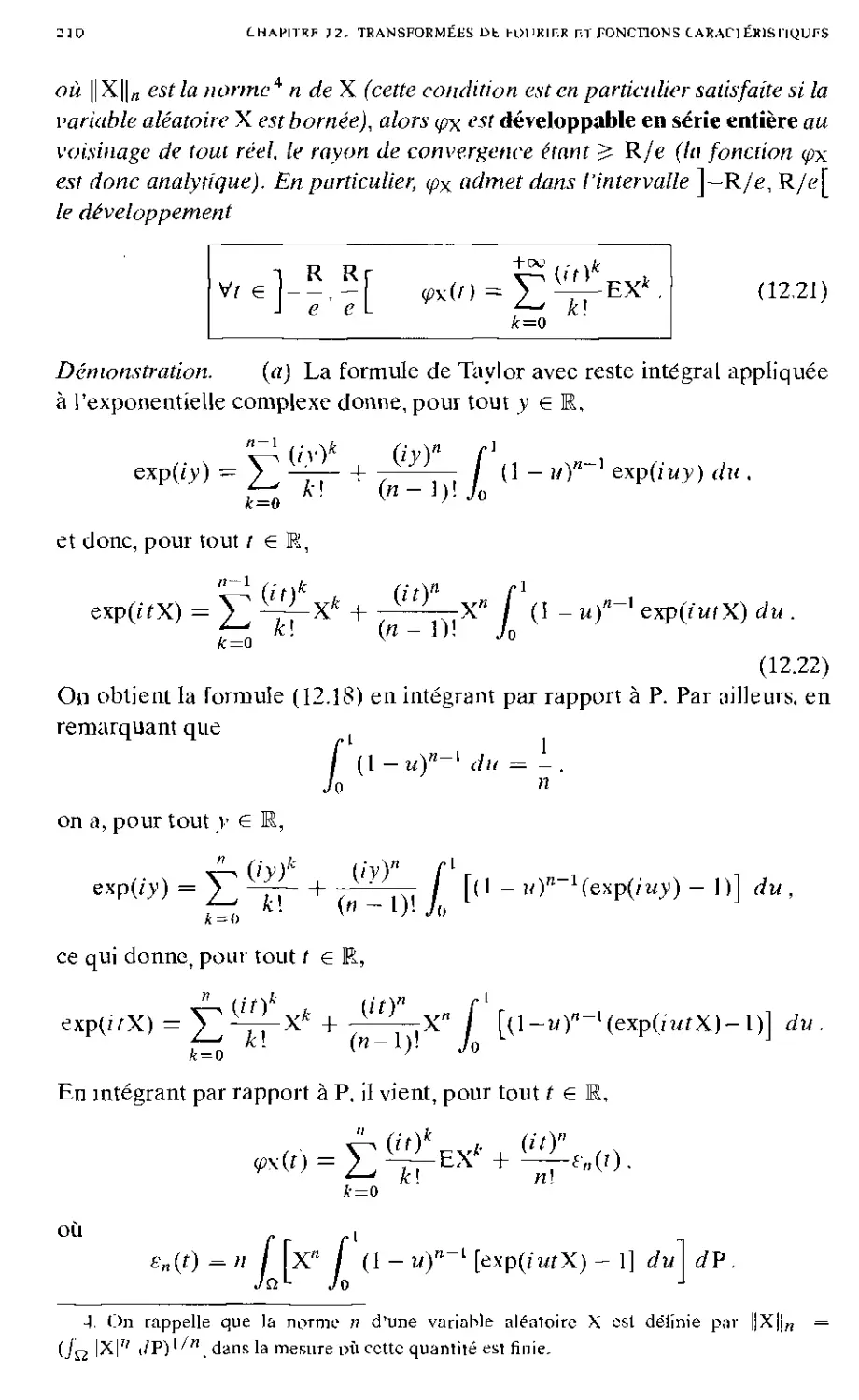

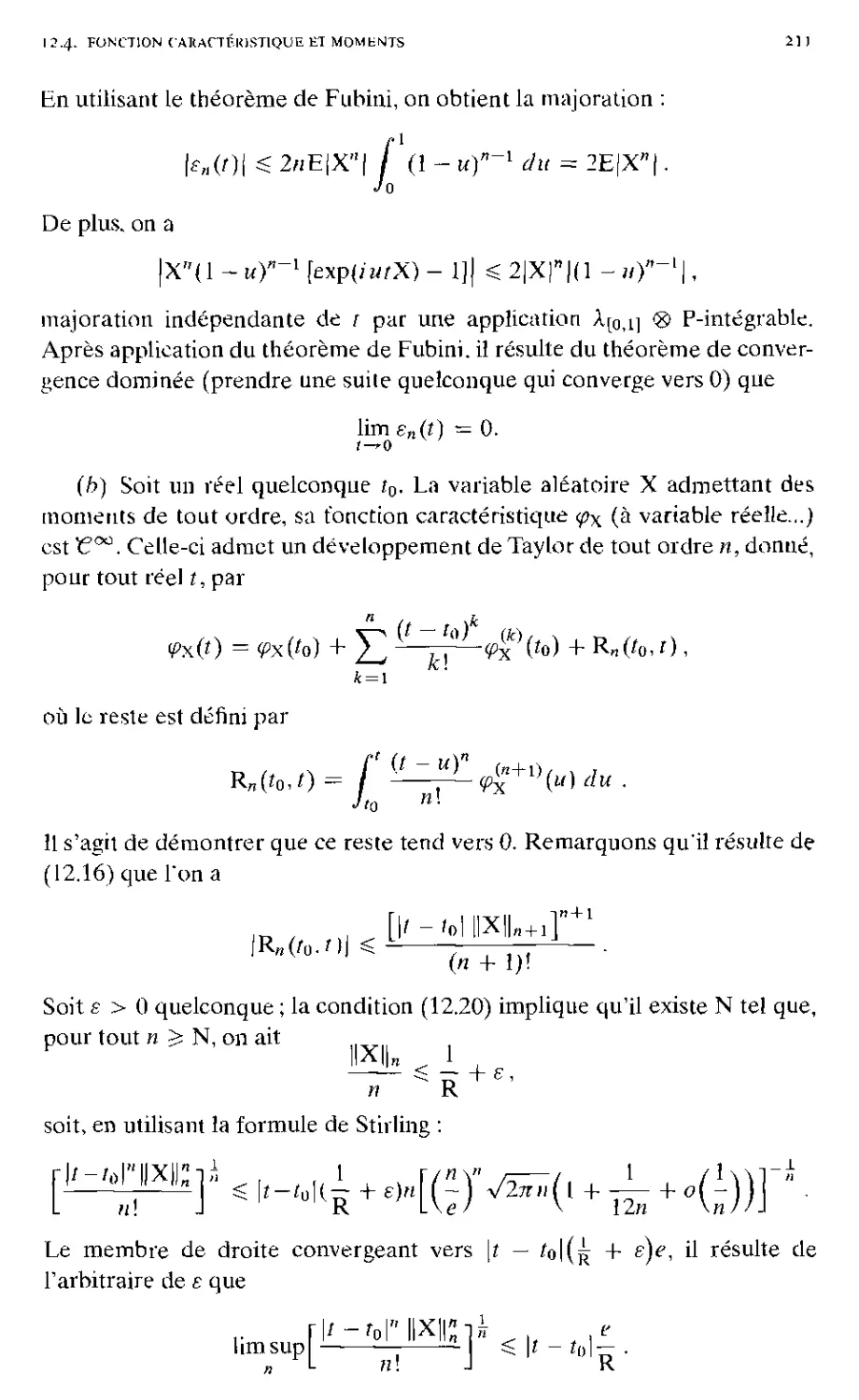

12.4. Fonction caractéristique et moments . 203

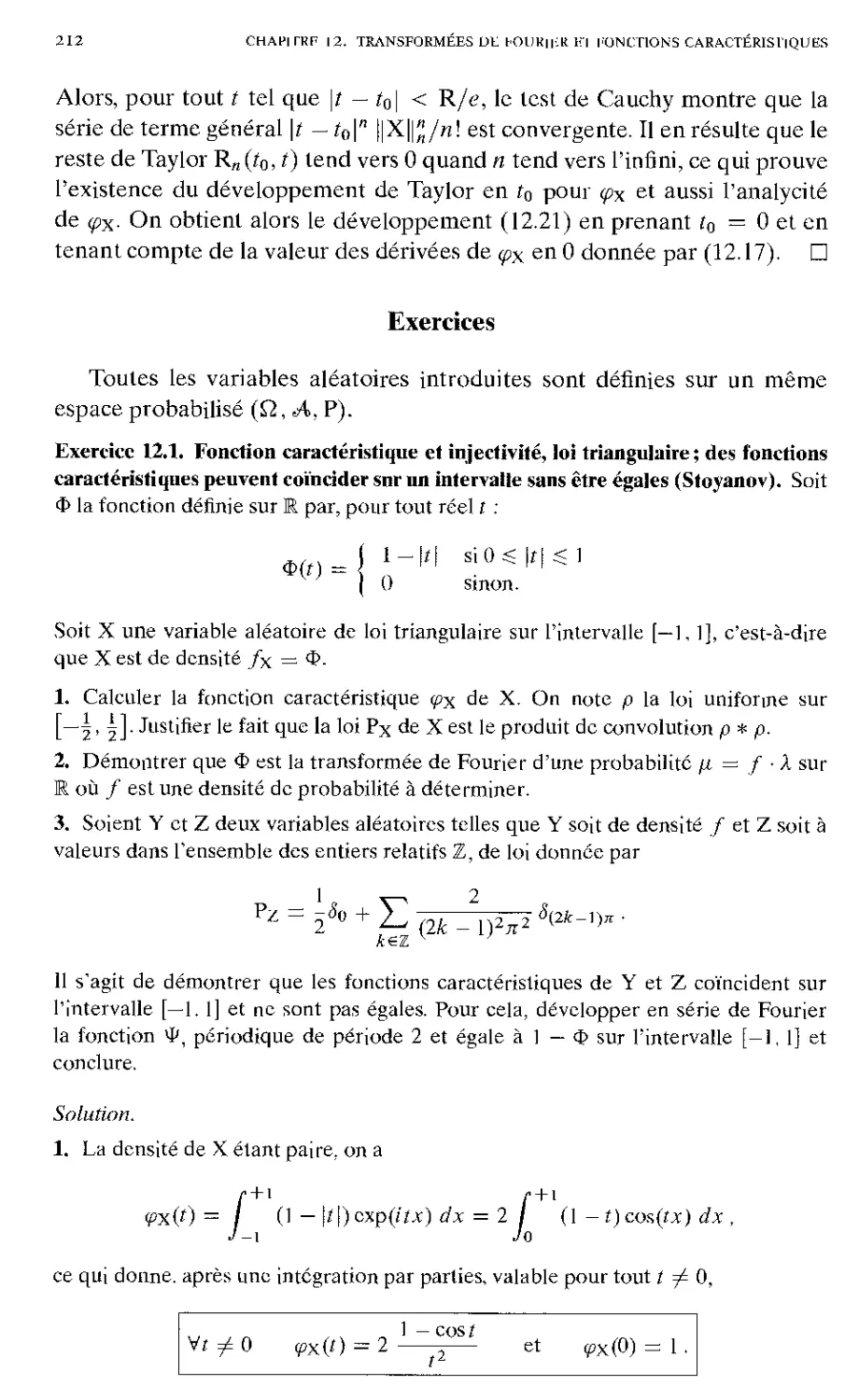

Exercices . 212

Chapitre 13. Variables aléatoires gaussiennes 235

13.1. Définition et propriétés 236

13.2. Existence des mesures gaussiennes. Condition d'absolue

continuité 238

13.3. Marginales 244

13.4. Régression ; le modèle linéaire . 250

13.4.1. Estimation des paramètres de régression 252

13.4.2. Le modèle linéaire gaussien 259

Exercices ¦ 2^7

Chapitre 14. Convergence de mesures et convergence en loi 289

14.1. Convergence de mesures bornées sur Rd ........... 289

14.2. Convergence en loi 3°3

14.3. Théorème limite central 3T3

14.4. Estimation 32«

Exercices 327

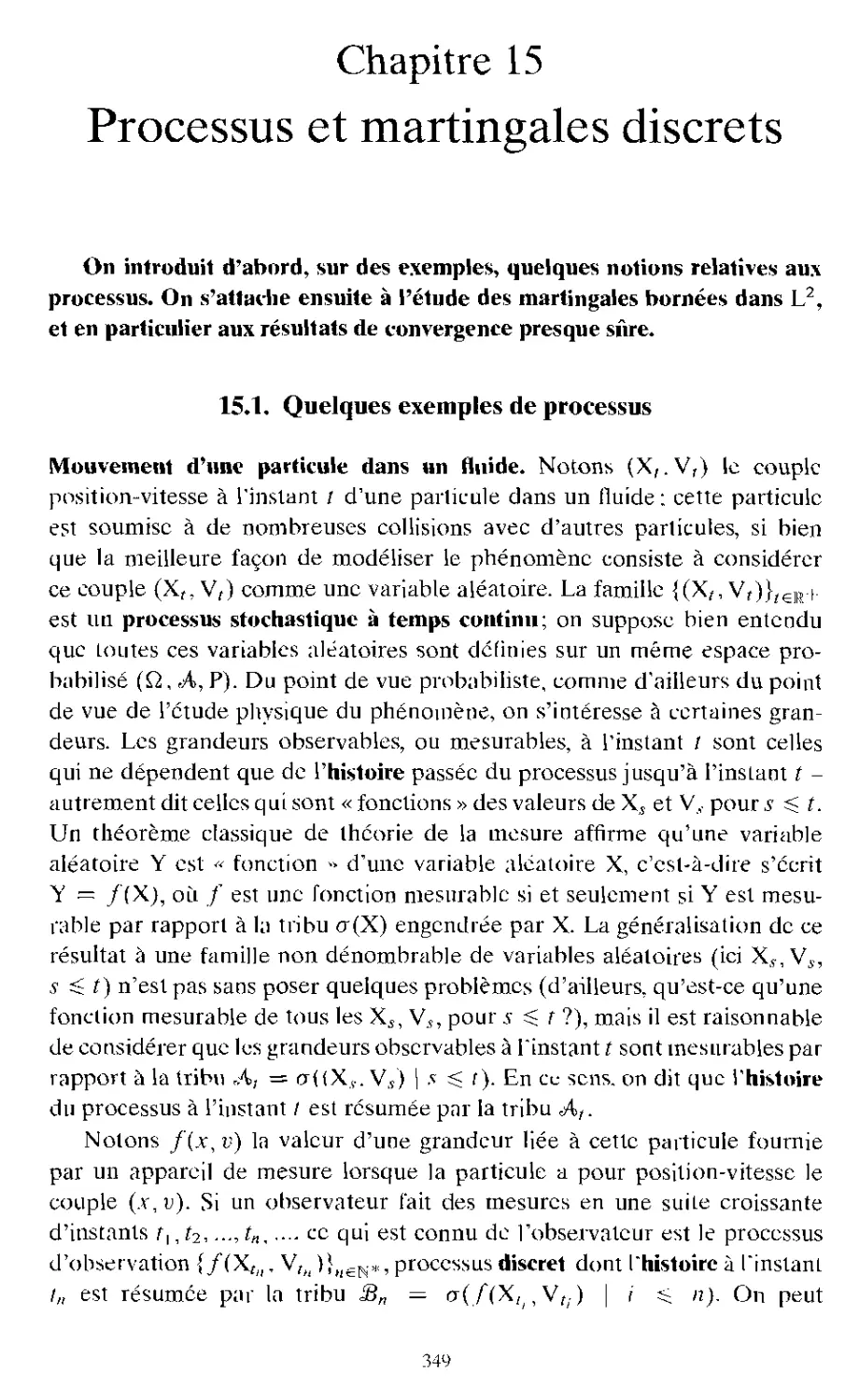

Chapitre 15. Processus et martingales discrets 349

15.1. Quelques exemples de processus ¦ 349

15.2. Processus et martingales : définitions 35i

15.3. Temps d'arrêt . 354

15.4. Premier théorème d'arrêt 35&

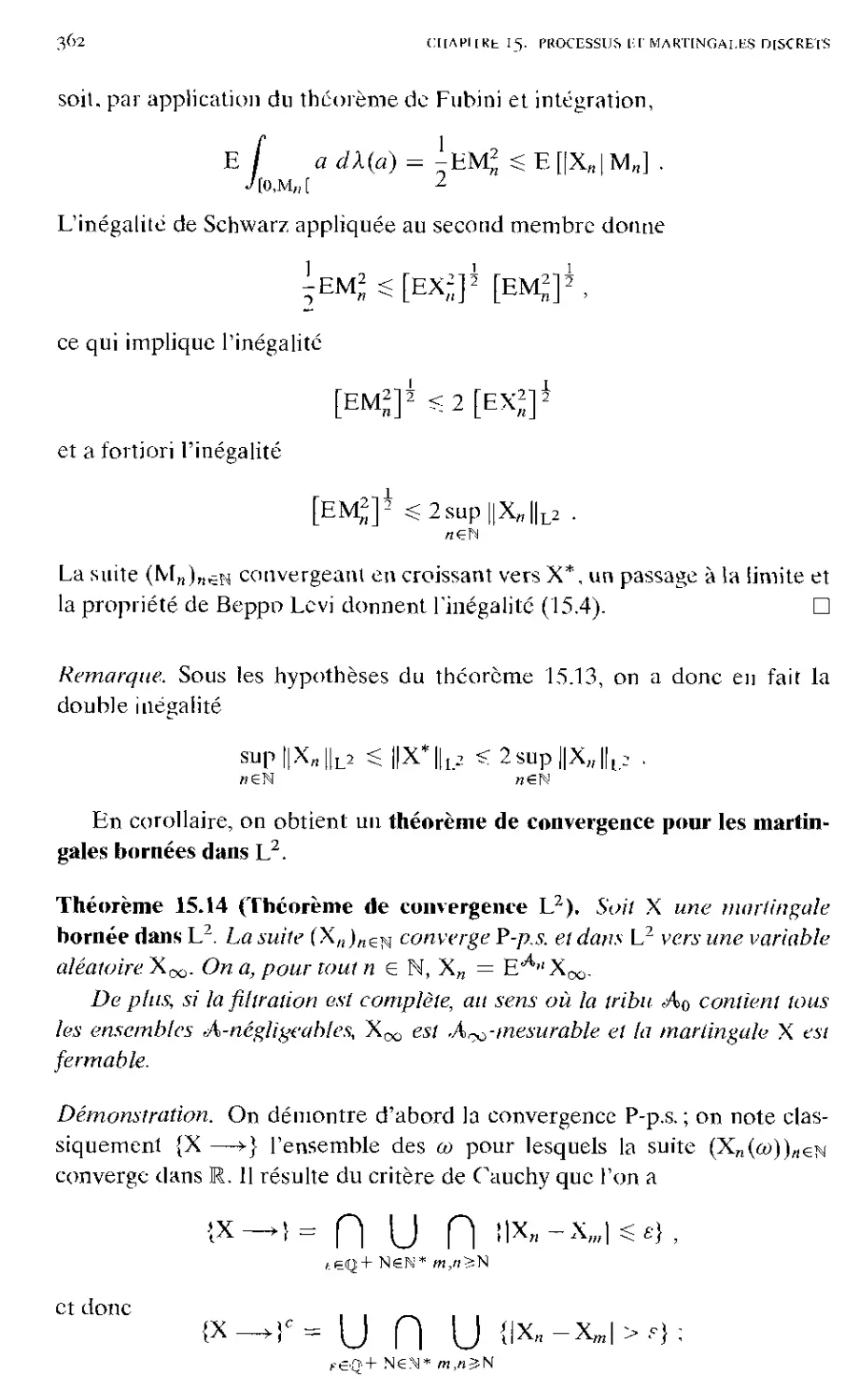

15.5. Lemme maximal et martingales dans L2 360

15.6. Décomposition de Doob 3^5

15.7. Convergence de martingales integrables . 3°9

15.8. Deuxième théorème d'arrêt 376

15.9. Convergence de sous- et surmartingales 378

Exercices 379

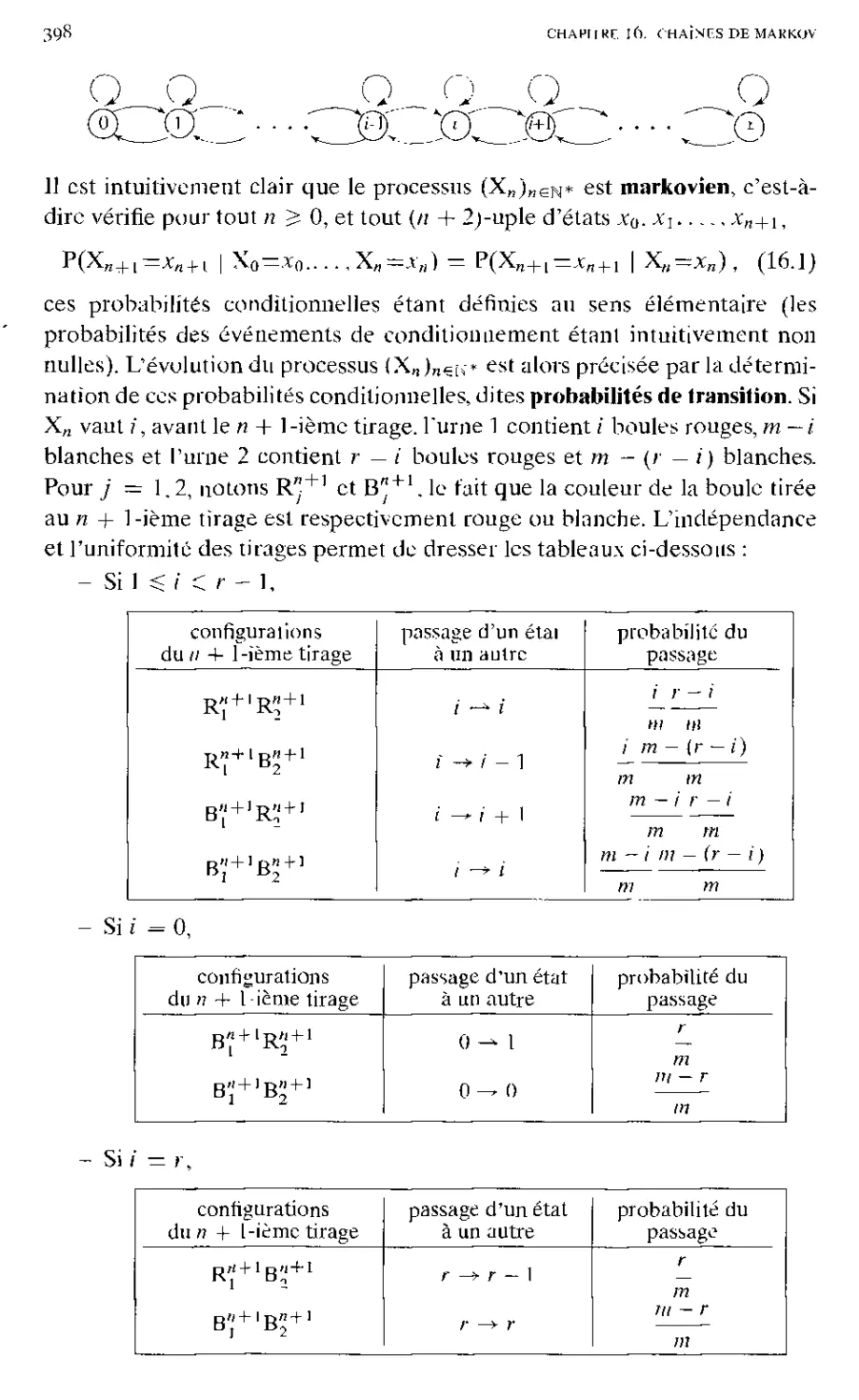

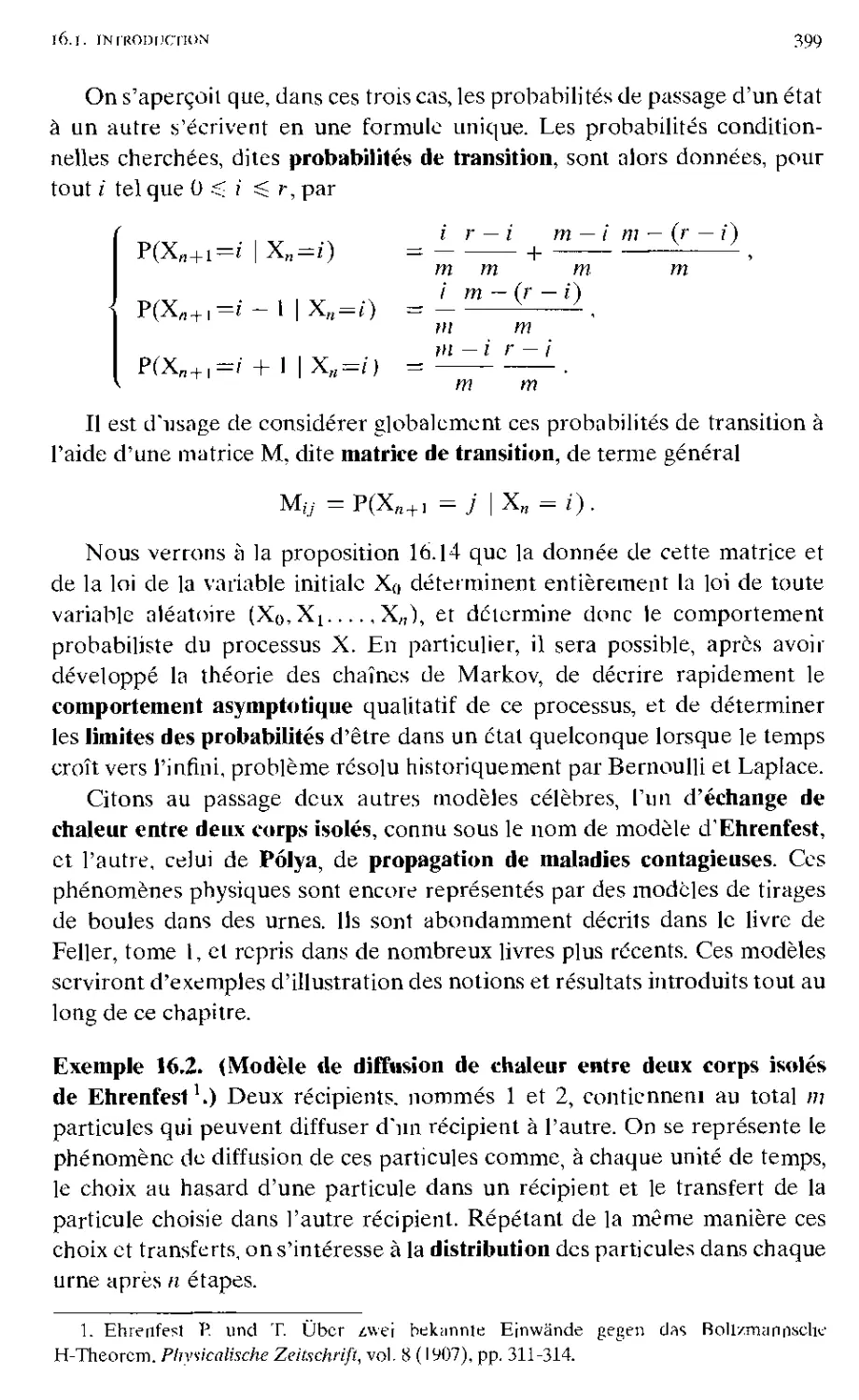

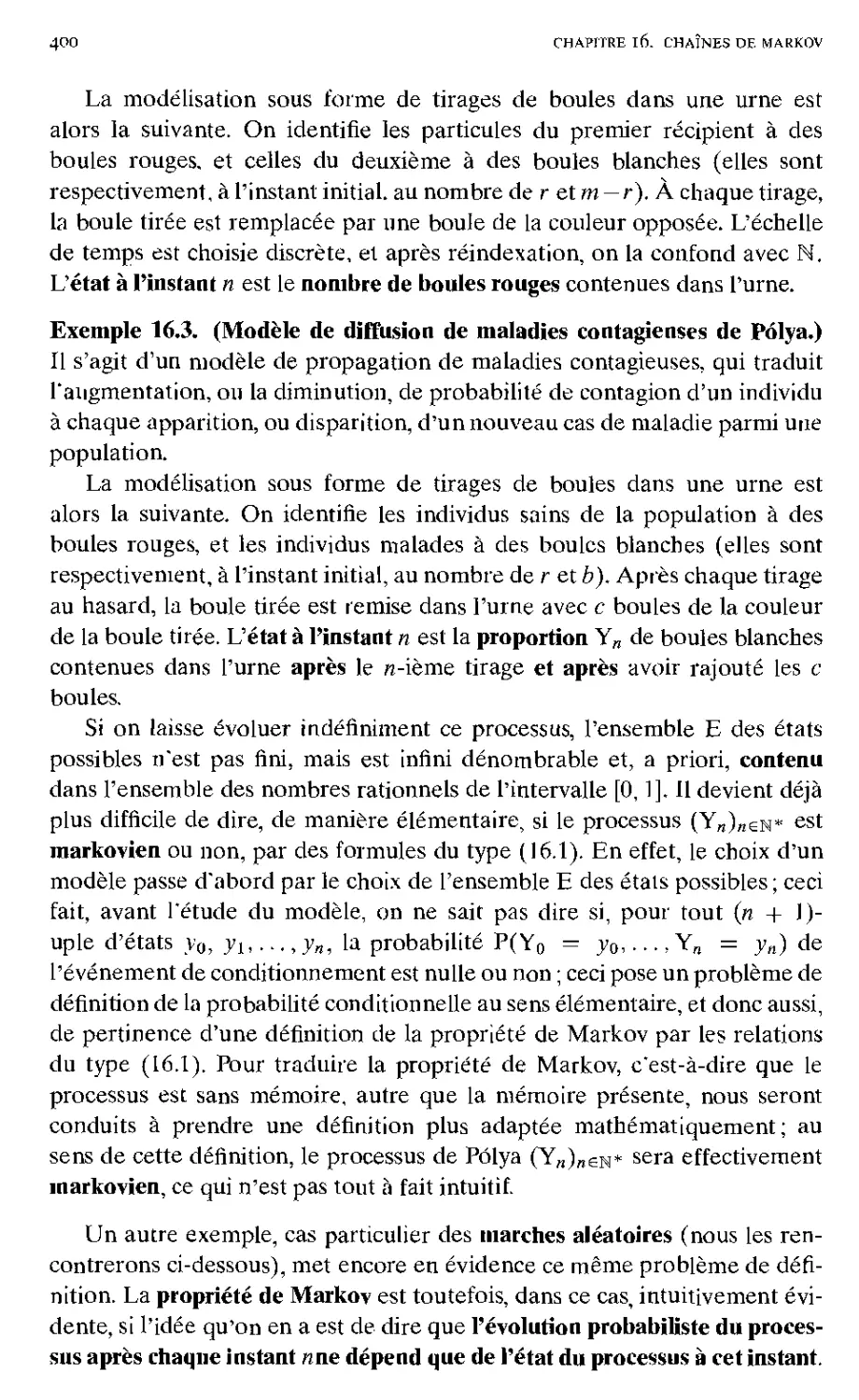

Chapitre 16. Chaînes de Markov 397

16.1. Introduction 397

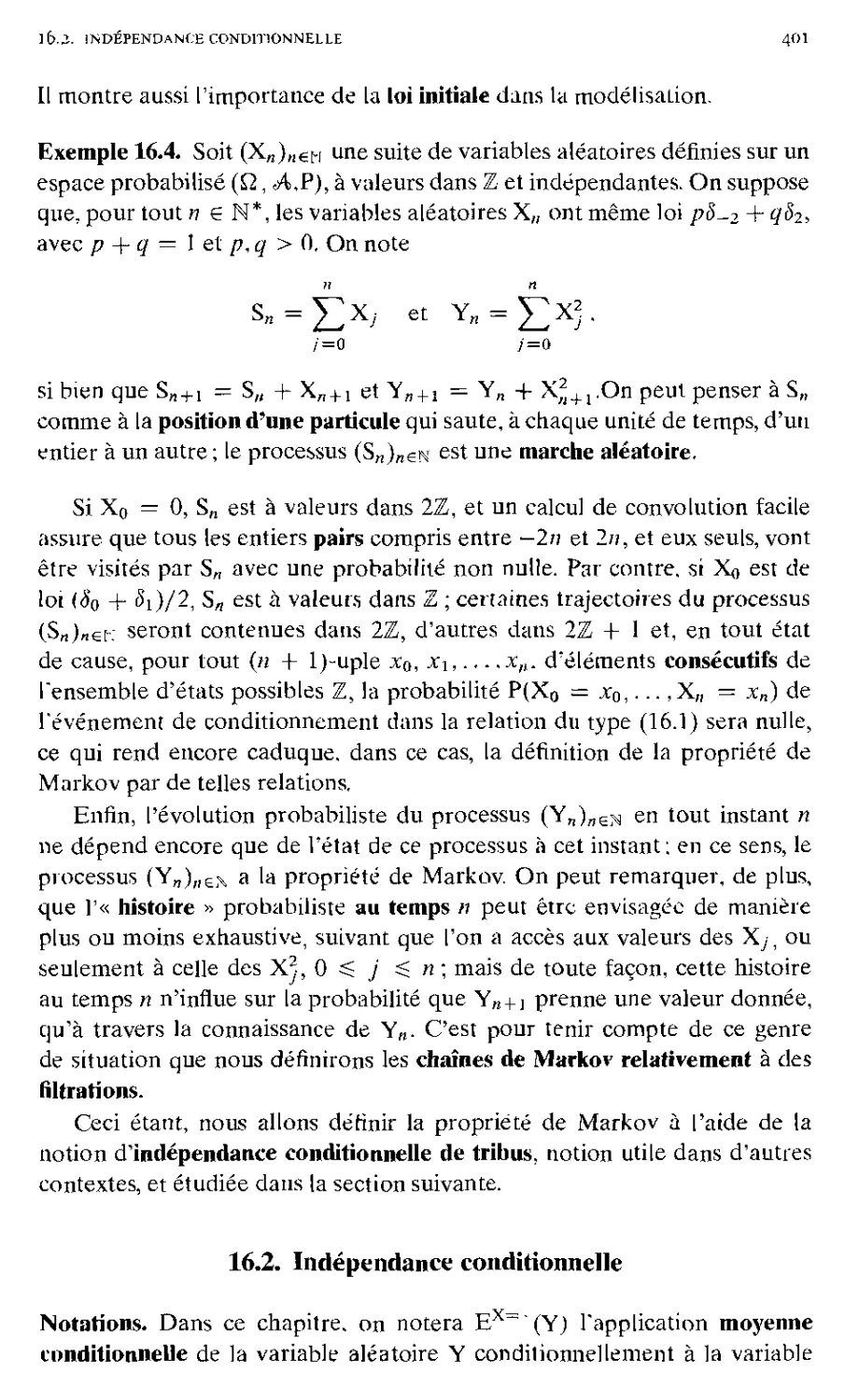

16.2. Indépendance conditionnelle 401

16.3. Chaînes de Markov : propriétés générales 405

16.3.1. Propriété de Markov ; matrices de transition 405

16.3.2. Propriété de Markov simple ; lois fini-dimensionnelles 417

16.3.3. Loi initiale ; propriété de Markov forte 422

16.4. Visites à un état fixe 426

16.4.1. Étude de la suite des temps de passage en un point . . 428

16.4.2. Lois du nombre de visites d'un point et du premier temps

de passage en ce point 430

16.5. Classification des états 435

16.5.1. Communication; périodicité 435

lb.5.2. Récurrence 440

16.5.3. Comportement asymptotique et classification .... 442

16.5.4. Critère analytique de récurrence 450

16.6. Calcul de la matrice potentiel et de P^(T], < +00) 453

16.6.1. Calcul de la matrice potentiel 453

16.6.2. Calcul de F(x, y) = Px(Tly < +00) 454

16.7. Mesures invariantes 457

16.8. Loi forte des grands nombres 470

16.8.1. Théorème de loi forte 470

16.8.2. Estimation de la matrice de transition 475

Exercices 477

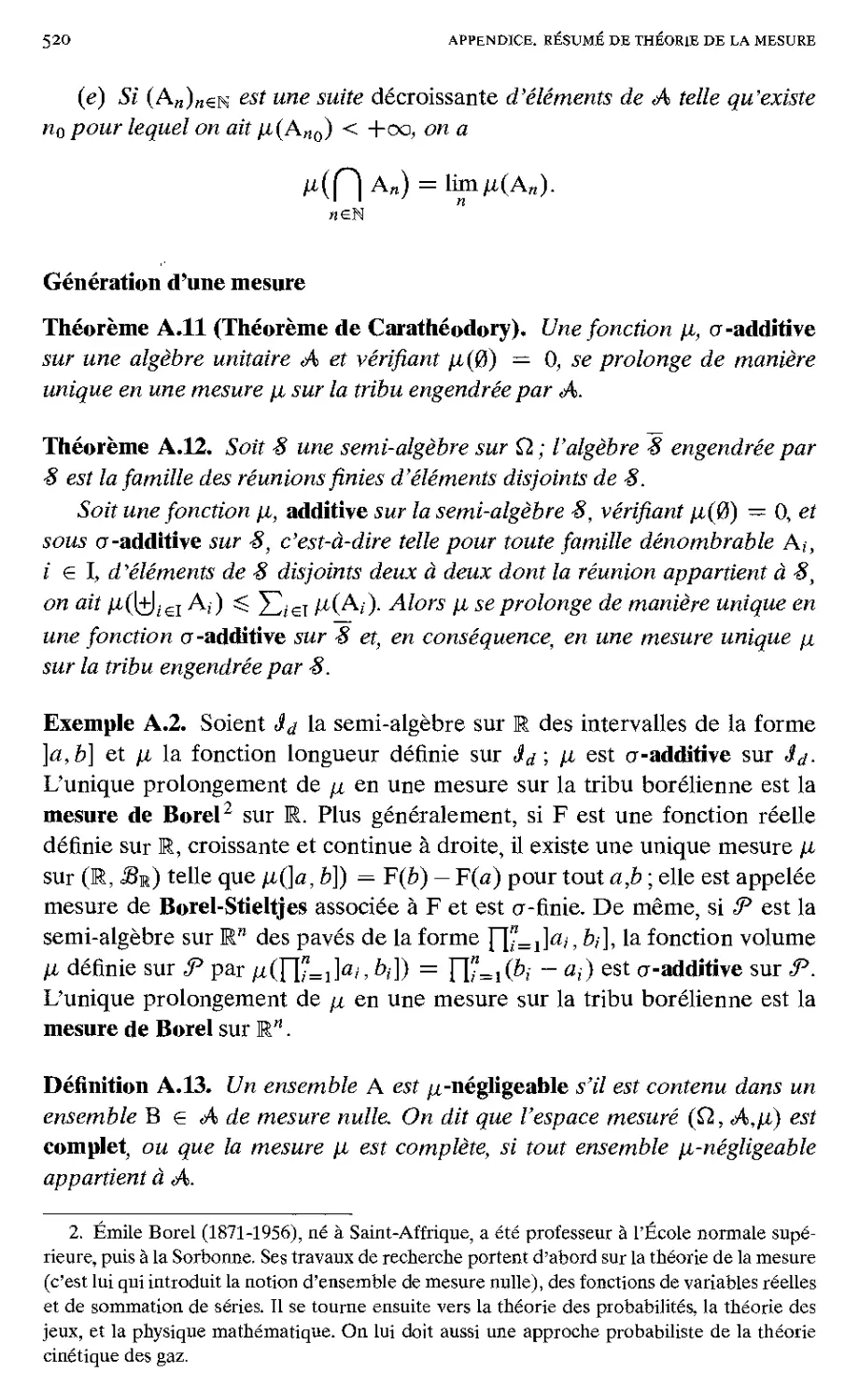

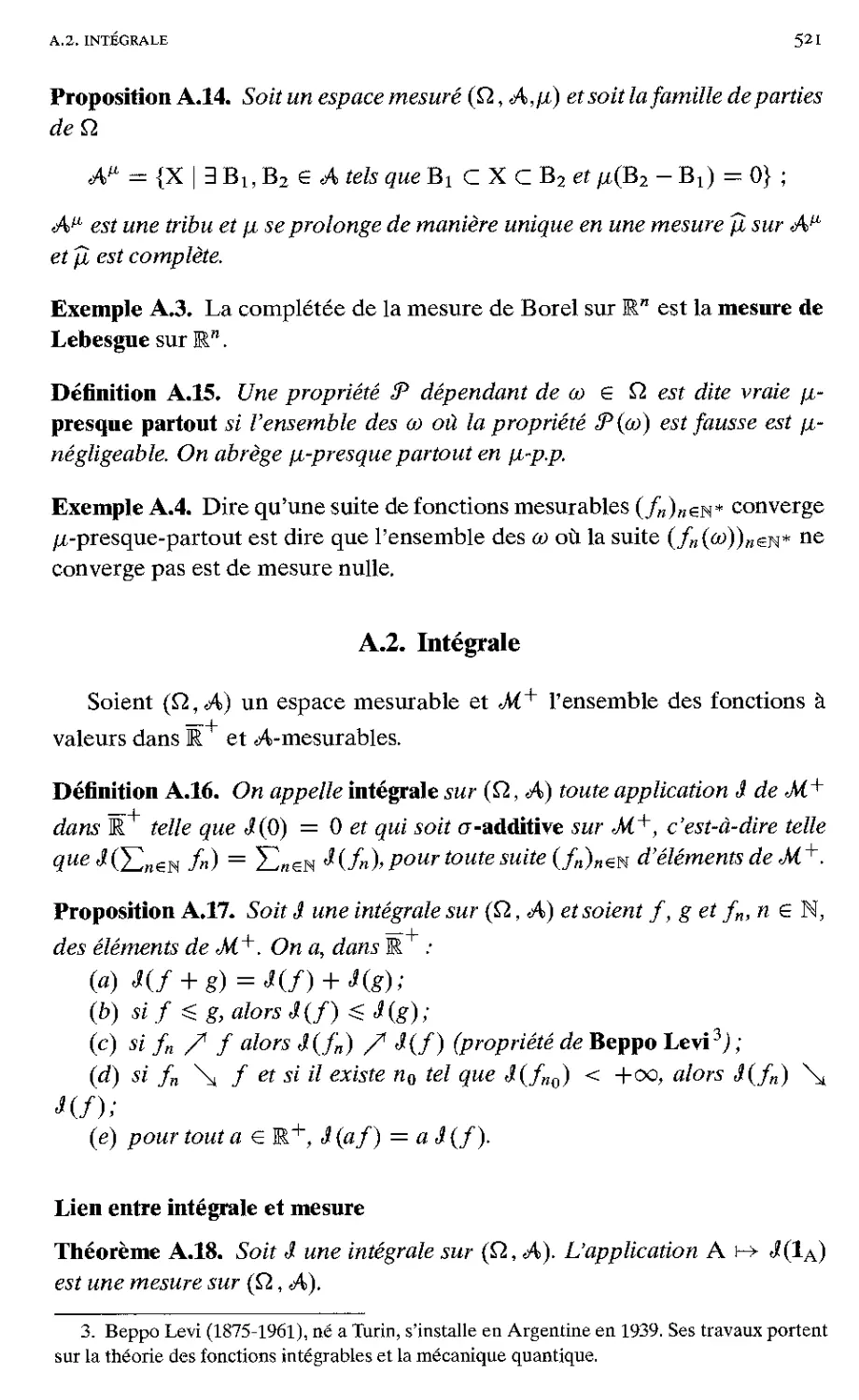

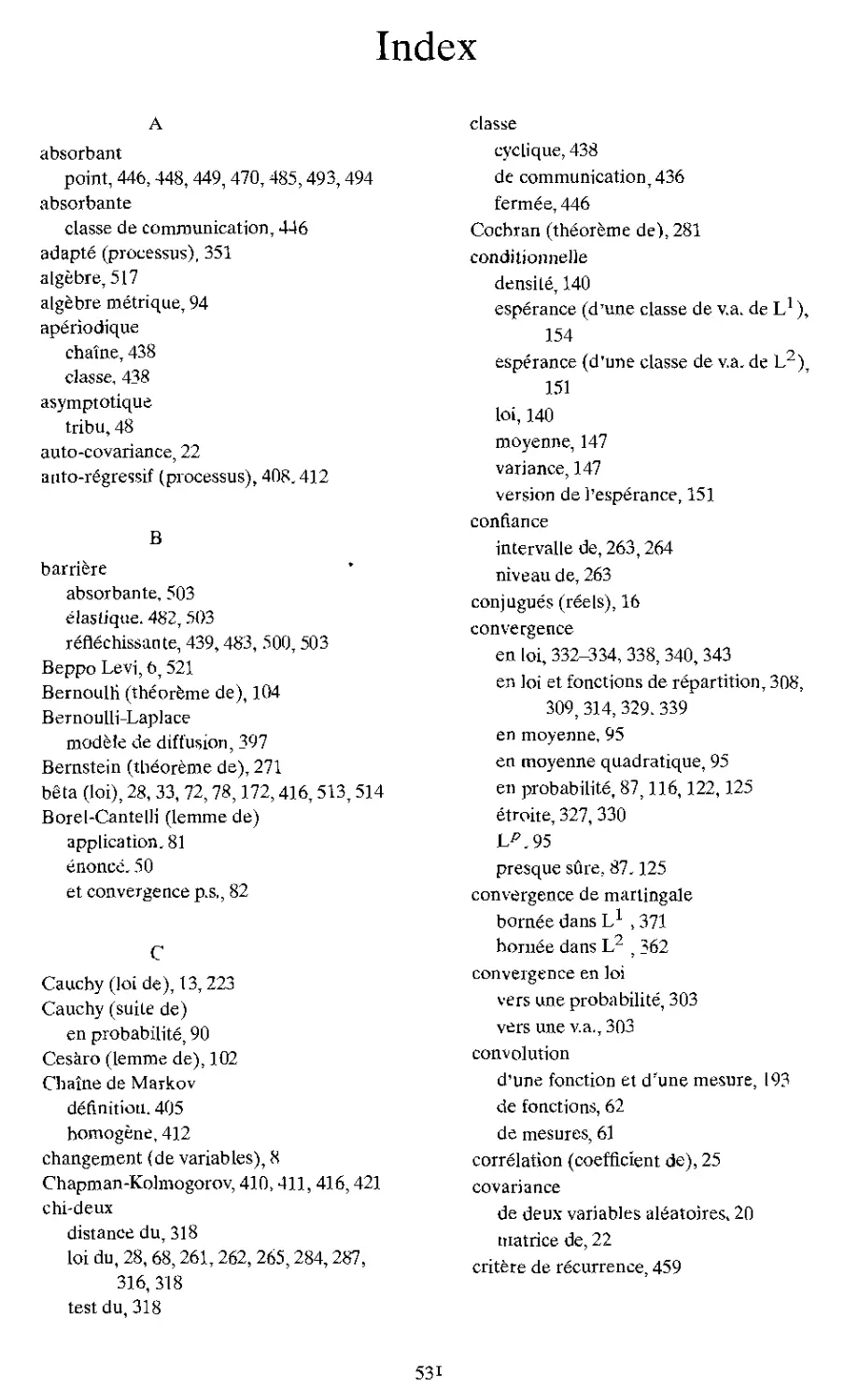

Chapitre A. Résumé de théorie de la mesure 517

A.]. Mesure et probabilité 517

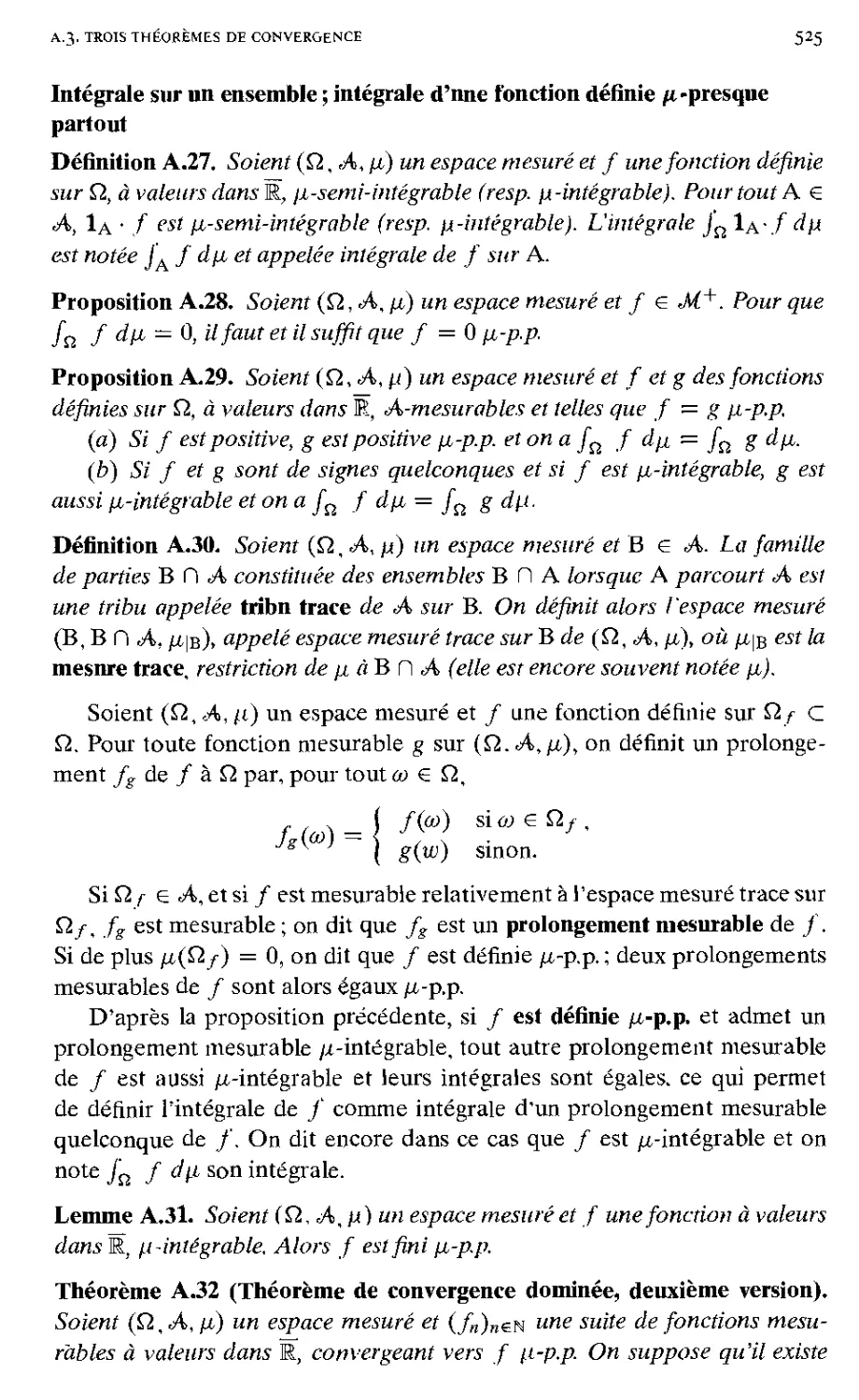

A.2. Intégrale 521

A.3. Trois théorèmes de convergence 523

A.4. Mesure produit et théorème de Fubini 526

Index 531

Liste des chapitres du premier tome

1. Phénomènes aléatoires et modèles probabilistes

2. Familles sommables de nombres réels

3. Indépendance

4. Probabilités et lois conditionnelles

5. Moments d'une variable aléatoire discrète

6. Variables aléatoires à densité

7. Approximation de lois. Loi faible des grands nombres

Introduction

^4 mon ami François Brodeau,

avec qui j'ai longuement participé

au jury de l'agrégation.

Le premier tome de cet ouvrage présentait la théorie élémentaire des

probabilités. Nous abordons maintenant l'exposé moderne de cette théorie, qui repose

entièrement sur la théorie de la mesure.

C'est grâce à elle que des fondements rigoureux ont pu être établis pour les

probabilités au xxu siècle, en faisant ainsi une véritable théorie mathématique. La

première note de Lebesgue sur le problème de la mesure date de 1901, l'introduction

du formalisme (Q, A, P) par Kolmogorov date de 1927.

Comme nous l'avons vu dans le premier tome, le simple emploi de ce formalisme

permet de donner un sens précis à la notion d'événement ou de variable aléatoire,

ou à celle d'indépendance. Ce n'était pas du tout évident avant Kolmogorov. Bel

exemple de modélisation réussie... Mais nous avons éprouvé certaines difficultés,

pour le cas des variables aléatoires à densité, à formuler l'analogue du théorème

de transfert, ou à justifier les critères usuels d'indépendance (cf. ch. 6, p. 190,

p. 201) : c'est qu'il faut pour cela toute la force de la théorie de la mesure ; de même

pour formuler et démontrer un résultat de convergence presque sure comme la loi

forte des grands nombres. On n'imagine plus à notre époque d'enseignement des

probabilités, y compris en vue des applications, en-dehors du cadre fourni par la

théorie de la mesure.

Cet ouvrage a été conçu à l'intention des candidats au CAPES et à l'agégation.

Mais la forme que nous lui avons donnée lui permet d'être utilisé tout au long des

études universitaires. Le premier tome sera utile aux étudiants de licence ou des

classes préparatoires. Le présent volume pourra servir de manuel aux étudiants en

master désireux d'approfondir leurs bases en probabilités.

Voici, dans la perspective des concours, un bref mode d'emploi de ces deux

volumes. Le premier correspond aux programmes du CAPES et de l'agrégation

interne. Le second répond aux besoins des candidats à l'agrégation externe. Dans

la configuration actuelle du concours (programme de 1999) on demande à tous

les candidats d'avoir une connaissance solide de la théorie, correspondant à nos

chapitres 8 à 14. Certaines questions de modélisation, mettant en jeu des variables

discrètes ou des lois de probabilité classiques, amèneront à se référer au premier

tome. Les chapitres 15 (martingales) et 16 (chaînes de Markov) sont destinés aux

candidats ayant choisi à l'oral l'option Probabilités et statistique (étant entendu

que certaines notions sur les chaînes de Markov finies sont exigibles de tous les

candidats).

Le candidat trouvera dans ce livre les matériaux pour construire lui-même sa

leçon, aussi bien dans le corps des chapitres que dans les très nombreux exercices

corrigés : ou notera que dans notre exposé chaque notion introduite est suivie d'un

i

introduction

exemple. I e candidat devra aussi au cours de sa préparation rechercher dans d'autres

sources des informations complémentaires et des exemples d'application, relatifs

notamment aux thèmes proposés par le programme de l'année. Il devra en outre

se former à l'utilisation d'un logiciel de calcul formel, et apprendre à illustrer avec

ce logiciel les sujets exposés; de nombreux exercices de ce livre pourront servir de

support à cette illustration.

Pour rendre l'ouvrage plus vivant, nous avons donné, sous forme de notes,

quelques renseignements biographiques sur les principaux mathématiciens qui ont

contribué à l'élaboration de la théorie des probabilités ; notre source d'information

principale a été le livre de B. Hauchecorne et D. Suratteau, Des Mathématiciens de

A à Z, (Ellipses, 1996, Paris). Enfin, nous avons donné en annexe un Résumé de

théorie de lu mesure, mais nous avons maintenu dans le corps de l'exposé, au début

du chapitre S. certains résultats essentiels au probabiliste qui ne figurent pas toujours

dans les cours d'intégration.

Je tiens à remercier les éditions Cassini : en rendant accessible cet ouvrage à un

public motivé par la perspective d'un concours, mais aussi curieux d'apprendre et

de réfléchir, elles me permettent d'apporter une aide, je l'espère fructueuse, à toute

personne qui aura eu la patience de me suivre.

Je remercie tout particulièrement André Bellaïche, avec qui j'ai eu de longues et

fructueuses confrontations sur cet ouvrage.

Enfin, je remercie les relecteurs de cet ouvrage; leurs remarques oui contribué au

polissage du manuscrit et conduit à la forme définitive de ce livre. Je souhaite que le

lecteur trouve ici matière à un travail agréable et enrichissant.

Chapitre 8

Lois et moments de variables

aléatoires

Dans ce second tome, nous supposons connue la théorie de la mesure

abstraite et de l'intégration. Le lecteur pourra trouver un résnmé détaillé de

cette théorie dans Pannexe figurant en fin de ce livre. À ces rappels, nous

ajoutons ci-dessous quelques compléments, en général omis dans les cours

d'intégration, mais indispensables en probabilités.

Dans la suite du chapitre nous donnons la présentation définitive, dans

le cadre de la théorie de la mesure, des notions de loi et de moments d'une

variable aléatoire.

8.1. Compléments de théorie de la mesure

Nous commençons par une élude du principe de prolongement par

mesnrabilité. très fréquemment utilisé en probabilités.

Définition 8.1. Une famille "G de parties d'un ensemble Q est appelée n-

système si elle est stable par intersection finie.

Une famille S de parties d'un ensemble Q est appelée A-système si elle

satisfait aux deux axiomes suivants :

(Ai) pour toute suite croissante (S„ d'éléments de S on a

U S„ e S;

(X2) pour tous éléments A et B de S tels que A C B, on a

B\AeS.

Nous aurons besoin de la notion de n-système (resp. À-système)

engendré par une famille £ de parties de Q. On observe d'abord que

l'intersection d'une famille quelconque de jt-systèmes (resp. de À-systèmes) est un

71 -système (resp. un A-système). De plus, -?"(£2) est à la fois un 7r-systètne et

un À-système; il existe donc un ix-système (resp. un À-système) contenant

JÉ. On définit alors le jr-système (resp. le À-système) engendré par £ comme

l'intersection de tous les jr-systèmes (resp. les À-systèmes) contenant <£.

3

4

chapitre 8. lois ct moments de variables aléatoires

On peut aussi caractériser le jr-système (resp. À-système) engendré par

X comme étant, au sens de l'inclusion, le plus petit tï-système (resp. A-

système) contenant X.

Remarque. Il faut noter que, tout comme dans le contexte des tribus, ce

procédé de définition par « fermeture » n'est pas constructif : en général,

on n'a pas d'expression explicite d'un élément générique du A-système

engendré par X. Toutefois, le tï-système engendré par X est la famille de

toutes les intersections finies d'éléments de X (cette famille est le plus petit

7T-système contenant X).

Exemples 8.1. Sur R, les familles constituées

- des intervalles ]a, b[, (a Hb);

- des intervalles ]a,b],[a $ b) ;

- des intervalles [a, b], (a $ b), et de l'ensemble vide ;

- des demi-droites [a, +oo[, (a € R) ;

- des demi-droites ]—oo, a], (a € R)

sont des 7T-systèmes.

De même, sur Rd, les familles constituées des ouverts, des ouverts

bornés, des fermés, des pavés de la forme rC=i[rt>'>^]' (ai ^ M et de

l'ensemble vide, sont des tï-systèmes.

Dans la suite, à maintes reprises, on rencontrera des A-systèmes. Pour

fixer les idées, voici un exemple de A-système qui n'est pas une tribu : si Q

est un ensemble non dénombrable. la famille de ses parties dénombrables

est à la fois un n-système et un A-système; toutefois, cette famille ne

contient pas Q, et plus généralement, elle n'est pas stable par passage au

complémentaire : ce n'est donc pas une tribu.

Les relations entre ces différentes structures sont précisées par le lemme

suivant.

Lemme 8.2. Pour qu'un A-système S sur Q soit une tribu sur Q, il faut et il

suffit que -S soit un n-système et que Q e S.

Démonstration. La condition nécessaire est triviale. Démontrons la

condition suffisante ; si S est à la fois un X-système et Tt-système sur Q qui contient

Q, S est stable par rapport au complémentaire (puisque Q e S) et par union

finie ; pour ce dernier point, il suffit de remarquer que si A et B sont des

éléments de S, Ac et Bc le sont aussi ; puisque l'on a

(A U B)'' = Ac n Bc,

et que S est un k -système, on a ( A U B)c e S, et donc aussi A U B e S. Reste

à démontrer que S est stable par union dénombrable. Si (A„)„eN* est une

suite d'éléments de S, on construit une suite (Bn)„^s* croissante d'éléments

8.1. COMPLÉMENTS DE THÉORIE De LA MESURE

5

de S ayant même réunion que la suite (A„)„eN* : il suffit de définir B„ par

récurrence en posant B] = Aj et pour « ^ 2,Bn = \J"=l Ay. ?

Le lemme suivant est d'usage fréquent en probabilités. Il permet

d'étendre une propriété possédée par une famille d'événements ayant la structure

de À-système à la tribu engendrée par cette famille.

Lemme 8.3 (Principe de prolongement par mesurabilité ; version ensem-

bliste). Soit S un A-système sur Q qui contient un 7T-système G et tel que

Q € S ; alors S contient la tribu a(G) engendrée par G.

Démonstration. Il suffit de démontrer que le X-système A engendré par G

et £2 est égalàaO?).

A est un n-système ; en effet, définissons, pour tout Ae^3 (Q), la famille

d'ensembles

AA = {B € A | B H A € A} .

A étant un X-système, on vérifie qu'il en est de même de AA. De plus :

AA C A. En particulier, pour tout A € G, puisque, par définition de A,

Q e AA et G C AA. on a AA = A, la famille A étant le plus petit A-système

contenant G et Q ; on a donc :

VA € G, VB € A B 0 A € A,

ce qui s'écrit : VB e A, G C AB. Mais alors. VB € A, la famille AB est un

X-système contenant G et Q, donc : AB = A. On vient de démontrer que,

VB € A, VC € A, B n C € A, c'est à dire que A est un n-système.

Il résulte du lemme précédent que A est une tribu et donc que : A D

a(G). Mais o(G) étant un X-système contenant G et Q, on a : A c aÇ€) ;

l'égalité A = a(G) en résulte. ?

Voici une application importante de ce lemme :

Théorème 8.4 (Théorème d'unicité des mesures). Soient fi} et ji2 deux

mesures positives sur l'espace probabilisable (Q, A) telles que

VA€£ fil(A)= fi2(A),

où G est un jt-système qui engendre la tribu A.

1. 5/ fÀi et fiz sont bornées et de même masse, alors ji\ — ¡12-

2. Si l'une des mesures fi] ou fi2 est non bornée, et s'il existe une suite

(E„)„eN d'éléments de G telle que Q — {Jn€Ti Ert et telle que

Vn € N fii(En) = fi2(En) < +00 ,

alors fi 1 — fi2-

6

chapitre S. lois et moments de variables aléatoires

Démonstration. Si /Xj et fi2 sont bornées et de même masse, la famille

S = {A € A | /X](A) — /i,2(A)} est alors un X-système contenant et Q ;

elle contient donc la tribu A engendrée par t?. Ceci démontre que ji\ = fj.2-

Pour le cas où l'une des mesures est non bornée, on considère les

restrictions de fi, et ji2 aux E„ ; d'après la première partie, elles sont égales

pour tout n. Par application de la formule de Poincaré (proposition 1.6,,

tome 1), qui reste valable pour des ine sures _/îmes (et c'est le cas pour chaque

restriction de ces mesures aux E„ ), les restrictions de p., et fi2 aux ensembles

F„ — Uo=s./=s« sont encore égales ; les mesures ¿1, et ji2 coïncident donc

sur Çl, puisque la suite d'ensembles F„ est croissante de réunion Çl. ?

Remarque. Les hypothèses du théorème impliquent que ¡1^ et fi2 sont

crûmes. De plus, il résulte de ce théorème que si deux probabilités coïncident

sur un jt-système engendrant A, elles sont égales.

Exemple d'application. Si deux mesures sur E coïncident sur toutes les

demi-droites ]—00,x], xeE, elles sont égales.

Le corollaire ci-dessous est très souvent utilisé en calcul des probabilités,

Notation. ¥?,x(?.d) (resp. ¥^(Ed)) désigne l'ensemble des fonctions

continues à support compact de Rd dans E (resp. et positives).

Corollaire 8.5. Soient fil et ¡12 deux mesures positives sur (Rd, 33Rd) finies

sur tout compact (on dit que ce sont des mesures de Radon). Si

les mesures [i\ et /x2 sont égales.

Démonstration. La classe *€ des ouverts bornés de Rd est un n-système. Les

mesures et fi2 coïncident sur ; en effet si O € 'C, il existe une suite

croissante d'éléments de (Rd) convergeant simplement vers lo-

D'après la propriété de Beppo Levi1 et l'hypothèse, on a :

Mi(O) = lim / fn dfii = lim / /„ dfi2 = /¿2(0) < +00.

Il suffit d'appliquer le théorème précédent. ?

Voici maintenant une version fonctionnelle du lemme 8.3.

Théorème 8.6 (Principe de prolongement par me&urabilité ; version

fonctionnelle). Soient 'C un n -système sur Çl et M un espace vectoriel de

fonctions réelles sur Çl tels que :

1. La propriété de Beppo Levl est aussi appelée théorème de convergence monotone,

8.1. compléments de théorie de la mesure

7

(i) pour toute suite croissante (/z„)„eN d'éléments positifs de M telle que

h m sup/( hn soit fini (resp. borné), on a h € M ;

(ii) In € M et, pour tout C € G, lc e ;

a/or¿' contient toutes les fonctions réelles a (G)-mesurables (resp. a(G)-

mesurables et bornées).

Démonstration. Il suffit de montrer que les fonctions 1a, A g g (G), sont

dans M. En effet, si c'est le cas, l'espace vectoriel M contiendra toute

fonction étagée cr(ï?)-mesurable, puisqu'une telle fonction s'écrit £]í€, îi(-1a(-

(I fini, ai g E et A¡ g a(G)). Toute fonction o-(ï?)-mesurable

positive finie (resp. bornée), étant limite croissante de fonctions étagées o(G)-

mesurables, sera alors dans M, en vertu de l'hypothèse (i). Enfin M

contiendra toute fonction o-(ï?)-mesurable finie (resp. bornée) h, puisqu'une telle

fonction se décompose sous la forme h — h+ — h~, où h+ et h~ sont

positives finies (resp. bornées) et <r(ï?)-mesui'ables.

Il reste à démontrer que les fonctions 1A, A e g (G), sont dans M, ce

qui s'écrit S D a(G), où on pose S = {A £ 3>(Q) | 1A € M). Par

hypothèse, on a S D G et Q e S. De plus S est un X-système car, d'une

part, 3t étant un espace vectoriel, pour tous Sj et S2 tels que S¡ D S2? on a

ls,\s2 = lsL — ls2 € M et, d'autre part, en vertu de la première hypothèse,

pour toute suite croissante (S„)„eN C S, on a l(j„eN s„ — suPn ls« e Il

résulte du lemme 8.3 que a (G) C S. Le théorème est démontré. ?

Nous terminons cette section en rappelant (sans en donner de

démonstration) les énoncés de quelques théorèmes d'usage constant dans la suite.

Définition 8.7. Soit ¡i une mesure positive sur l'espace probabilisable (Q, A).

Soit f une fonction numérique mesurable positive définie sur cet espace. La

mesure : A \~> fAf d{i est dite niesnre de densité / par rapport à ti et

notée2 f ¦ il.

Définition 8.8. Une mesure v sur (Q, A) est dite absolnment continue par

rapport à fj. si, pour tout A € A tel que /a (A) = 0, on a y (A) = 0. On note :

v « il.

Les mesures ti et v sur (Q, A) sont dites étrangères s'il existe N g A tel

que ¿i(N) - 0 et v(Nc) = 0. On note : v _L ti.

Exemple 8.2. La mesure de Lebesgue X sur E et la mesure de Dirac So en 0

sont étrangères, puisque A({0}) = ^({O}*') ~ 0.

Si v — / • /i, on a bien sûr v p.. La réciproque fait l'objet du

théorème de Radon-Nikodym (cf. par exemple Neveu ou Métivier pour une

démonstration).

2. Cette notation est justifiée par la formule (8.1).

8

chapitre 8. lois et momen (s de variables aléatoires

Théorème 8.9 (Théorème de Radon-Nikodym). Soit sur un espace

probabilisable (Q, A) une mesure a-finie ¡á et une mesure v telles que v \x; alors

il existe une fonction mesurable positive f (unique à une équivalence ¡i-p.p.

près) telle que v — f ¦ ¡i.

Proposition 8.10 (Intégration par rapport à nne mesure à densité). Soient

¡i une mesure positive sur l'espace probabilisable (£2, A) et f une fonction

numérique mesurable positive définie sur cet espace. Soit v — f ¦ ¡xla mesure

de densité / par rapport à \i. Soit h une fonction mesurable sur (Q, A).

- Si h est positive, on a :

- Si h est de signe quelconque, pour que h soit v-intégrable il faut et il

suffit que h ¦ f soit ¡.i-intégrable et, dans ce cas, l'égalité (8.1) est encore

Définitiou 8.11. Soit T une application mesurable de l'espace

probabilisable (Ei. 8] ) dans l'espace probabilisable (E2. 82)- Soit ¡i\ une mesure sur

(Bl, La mesure sur (E2, B2) définie par

est appelée mesure image de par T et notée Tf/^).

Théorème 8.12 (Théorème de la mesure image, ou théorème de transfert).

Soit T une application mesurable de l'espace probabilisable (Ej,^) dans

l'espace probabilisable ÇE2, &i); soit T(/Ai) la mesure image de ¡ix par T;

soit h une fonction mesurable sur (E2, B2).

— Si h est positive, on a :

- Si h est de signe quelconque, pour que h soit Ti^i^-intégrable il faut

et il suffit que h o T soit ^x -integrable et, dans ce cas, l'égalité (8.2) est

encore valable.

Théorème 8.13 (Théorème de changement de variables). Soit T un dif-

féomorphisme d'un ouvert U de Rd sur un ouvert V de Rd, de classe C1.

Soit f une fonction réelle mesurable définie sur U. Alors f est Lebesgue-

intégrable sur U si et seulement si la fonction v \-+ \ det (T-1 ) (u) | /' [T-1 (v)]

est Lebesgue-intégrable sur V. Dans ce cas, on a :

(8.1)

valable.

VB€g2 Ja2(B) = Ja1[T-1(B)]

S f(x)dXd(x) = f IdetiT-'yOOl/tT-1^)] dXd(v). (8.3)

8,2. loi d'une variable aléatoire

9

Remarque, On dit souvent que le second membre de (8.3) s'obtient à partir

du premier membre au moyen du changement de variable v = T(a), ou

x — T_1(t')i v est la « nouvelle » variable, x 1"« ancienne ». De plus,

det(T_1)'(u) est souvent noté ^ et est appelé jacobien du changement de

variable.

8.2. Loi d'une variable aléatoire

Toutes les variables aléatoires seront définies sur un même espace pro-

babilisé (Q, A, P). Une variable aléatoire X à valeurs dans l'espace proba-

bilisable (E, S) est alors par définition une application mesurable de (Q, A)

dans (E, S) c'est à dire une application telle que :

VB€S X~i(B)eA.

Définition 8.14. On appelle loi (ou loi de probabilité) de la variable aléatoire

X à valeurs dans l'espace probabilisable (E, g) la mesure image Py de P par

X.

Afin d'étendre aux variables aléatoires à valeurs dans W1 (d > 1) la

notion de fonction de répartition, on introduit un ordre partiel sur Rd en

posant

x ^ y si et seulement si V/ — 1, 2,..., d x¡ ^ y; .

Pour d — 1, on retrouve l'ordre habituel (total) sur E.

Définition 8.15. Soit X une variable aléatoire à valeurs dans (Rd, ¿8ffij ).

(a) On appelle fonction de répartition de X la fonction Fx de M.d dans

E+ définie par

V.v e Rd Fx(x) = P(X ^ x).

où ^ est l'ordre partiel usuel de M.d.

(b) On dit que X admet la fonction f pour densité si sa loi Px admet f

pour densité par rapport à la mesure de Lebesgue Xj sur Rd.

Si une variable aléatoire X possède une densité toute fonction Xj-

presque partout égale à / est encore une densité de X et inversement

toute densité de X est A^-presque partout égale à /. La densité de X est

donc définie à l'égalité A^-p.p. près et on la confond souvent avec sa classe

d'équivalence pour cette relation, qu'on note fx. La densité de X vérifie

donc

VA e Sjtd

PX(A) = [ fx{x)dXAx)-

Ja

10

chapitre 8. lois et moments de variables aléatoires

Le théorème d'unicité des mesures permet d'affirmer que pour que X

admette une densité, il faut et il suffit qu'il existe une fonction positive /x de

X1 (Rd, SRd, Xd ) qui vérifie ;

Vx €

FX(

= / fx(u) dXd{u)

(8.4)

En particulier si d = 1 et s'il existe une fonction positive fx integrable au

sens de Riemann qui vérifie

Fx(*)

¦L

]~oa,x]

/x(«) dX(u),

en remarquant que, dans ce cas, cette intégrale est aussi une intégrale

de Riemann, on retrouve la définition élémentaire d'une densité donnée

antérieurement (chapitre 6).

Si la loi Px est une mesure à densité par rapport à la mesure

dénombrement de M.d, la variable aléatoire est discrète (cette définition est un

peu plus générale que celle donnée dans le premier tome). L'ensemble

val(X) — {x | P(X = x) 7^ 0} est alors dénombrable et l'on a, Sx désignant

la mesure de Dirac en x,

VAe£R, Px(A)= Y P(X = *)MA),

xev&HX)

ce qui, en termes de probabilités, s'écrit

Px= Y p(x = *>^

*eval(X)

On rappelle que, pour une telle variable aléatoire discrète X, on a

/ € Xl{Rd, iBBd,Px) si et seulement si

Y ?)|P(X = .v)<

-oo

et que, s'il en est ainsi, on a

f fdpx= Y /(*)p<x = *).

Remarque importante. Si X est à valeurs dans (Rd,iîRd), il résulte du

corollaire 8.5 que sa loi est entièrement déterminée par la famille des

intégrales jQ f(X) dP = fR<i f dPx où / parcourt Ceci

fournit un procédé très efficace pour étudier la loi d'une variable aléatoire à

valeurs dans (Rd, i8Rd), les théorèmes d'intégration s'appliquant tous sans

problème.

8.2. loi d'une variable aléatoire

h

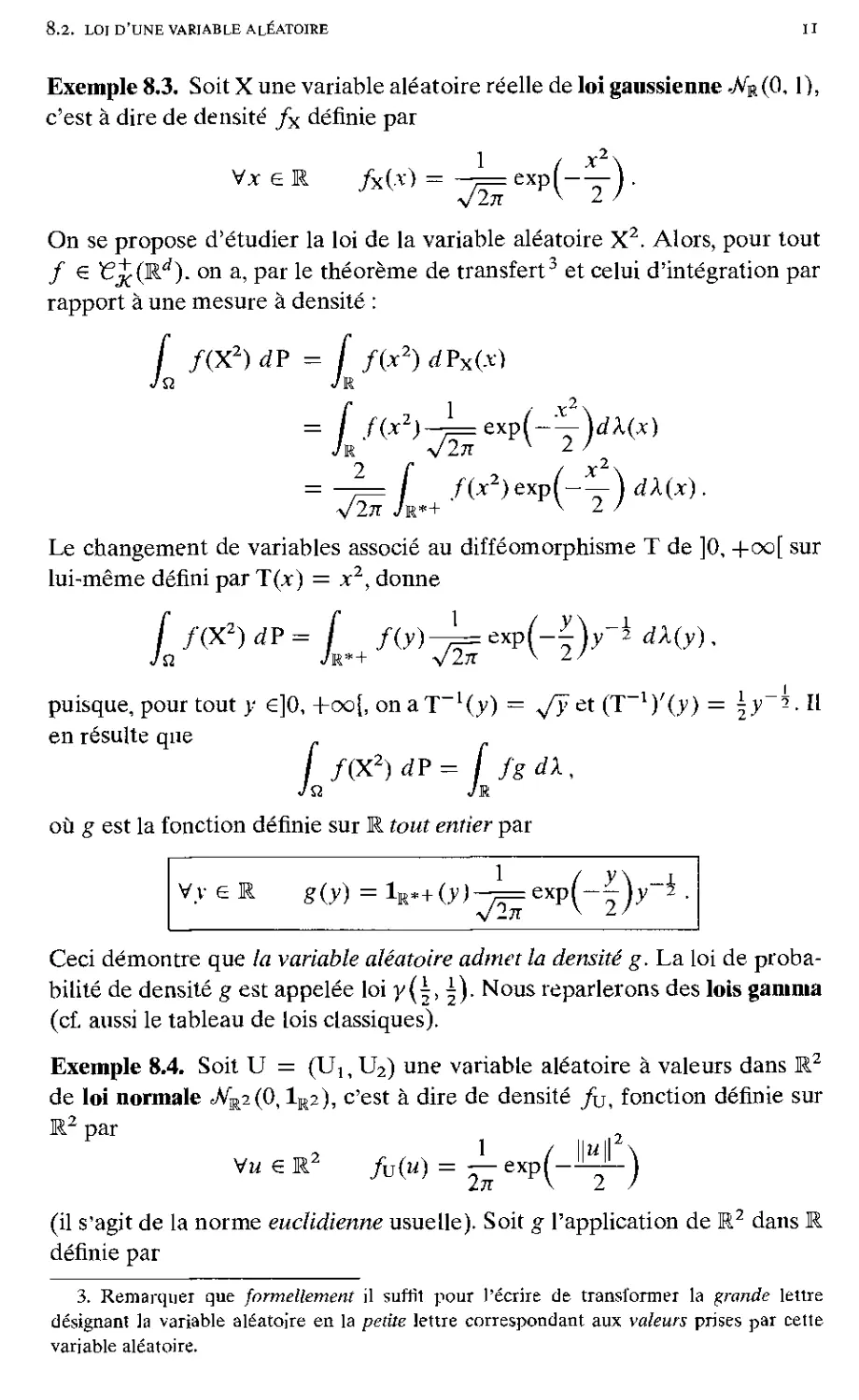

Exemple 8.3. Soit X une variable aléatoire réelle de loi gaussienne -JVr(0, 1),

c'est à dire de densité fx définie par

,2-

1

'In

exp

(-y)-

On se propose d'étudier la loi de la variable aléatoire X2. Alors, pour tout

/ € ¥?j£(Rd). on a, par le théorème de transfert3 et celui d'intégration par

rapport à une mesure à densité :

f f(X2)dP = f f(x2)dPx(x)

Jq Jr

= f f(x2)^exp(~^)dX(x)

Jr V2n v 2 /

= ~7=f f(x2)exp(^)dX(x).

Le changement de variables associé au difféomorphisme T de ]0, +oo[ sur

lui-même défini par T(x) = xz, donne

f /(X2)dP= f f(y) 1

'Iti

exp

H)

y\-2 dX(y),

puisque, pour tout y e]0, -foci on a T_1(y) = */y et (T l)'(y)=±y ?. Il

en résulte que

/ f(X2)dP= / fgdk,

Ja Jr

où g est la fonction définie sur R fowf enfr'er par

1 /

y \ r

Vy 6 R

g (y) = V+(.V)^==exp[-

V27T V

2/

Ceci démontre que la variable aléatoire admet la densité g. La loi de

probabilité de densité g est appelée loi y(^, Nous reparlerons des lois gamma

(cf. aussi le tableau de lois classiques).

Exemple 8.4. Soit U = (1^, U2) une variable aléatoire à valeurs dans R2

de loi normale ^V"K2(0,1K2), c'est à dire de densité fu, fonction définie sur

par

Vw € R2 fv(u) = ~- exp(-^L)

(il s'agit de la norme euclidienne usuelle). Soit g l'application de M2 dans

définie par

3. Remarquer que formellement il suffit pour l'écrire de transformer la grande lettre

désignant Ja variable aléatoire en la petite lettre correspondant aux valeurs prises par celle

variable aléatoire.

12 chapitre 8. lois et moments de variables aléatoires

7t 1 + X

1 , . ( — Si M2 # 0

VM € R g(H|,Mz) = { »2

( 0 si m2 = 0,

et soit X = g(V). On se propose d'étudier la loi de la variable aléatoire

X. Pour tout / € Ï?£(R2), il résulte du théorème de transfert et de celui

d'intégration par rapport à une mesure à densité que (se rappeler que la

mesure de Lebesgue d'une droite de R2 est nulle) :

J f(X)dP - J if o g)(x) dPx(x)

= f f?)± exp(-^)^2(W,M2).

Soit T le difféomorphisme de R2 \ {u2 = 0} sur lui-même défini par

T(w,,m2) = f—."a) ;

Vw2 '

son inverse T_1 est déterminé par les systèmes équivalents suivants

ce qui donne

T"1(-ï.y) = (-ry.y)-

En faisant le changement de variables associé à T, de jacobien

det(T-1)'(*, y), encore noté Dfy'uyf, et qui vaut

D(ui.m2) _ i v -v | _

D(x,y) ~ 1 0 1 1 ~ y '

il vient

f f(X)dP = f f(x)±QXp{JlJrf)y2\\y\dx2(x.y),

(ne surtout pas oublier la valeur absolue du jacobien), soit encore, puisque

une droite est de mesure de Lebesgue nulle,

£ /(X) dP = /(x)^exp(-U + *2)>;2)|y| dX2(x.y).

D'après le théorème de Fubini, applicable automatiquement pour les

fonctions mesurables positives, on a alors

c i î

= / f(x)-T~^dX{x).

Jr

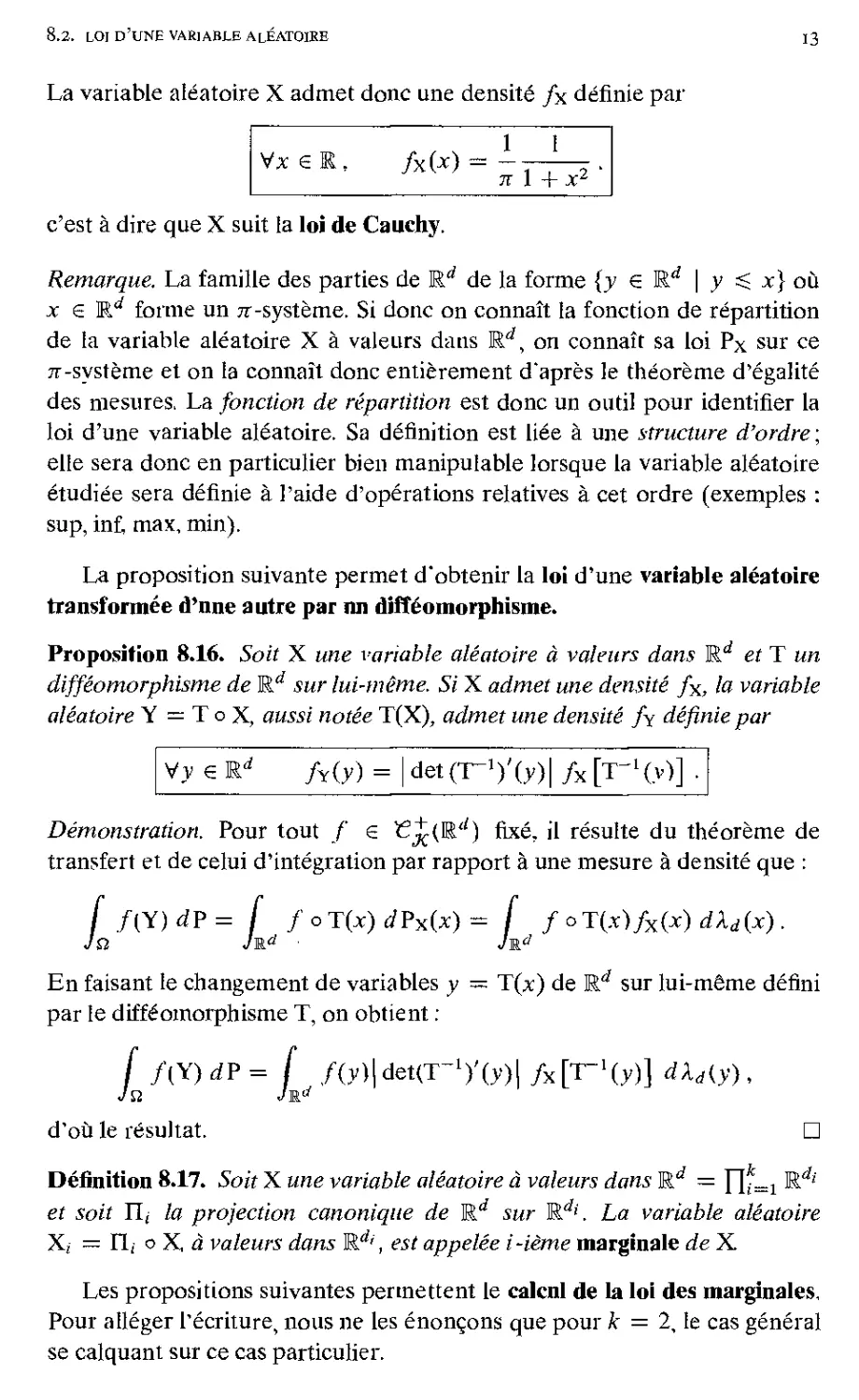

8.2. loi d'une variable aléatoire 13

1 I

7T 1 + X2

c'est à dire que X suit la loi de Cauchy.

Remarque. La famille des parties de Erf de la forme {y € Ed \ y ^ x} où

jc 6 Ed forme un 7T-système. Si donc on connaît la fonction de répartition

de la variable aléatoire X à valeurs dans Erf, on connaît sa loi Px sur ce

71 -système et on la connaît donc entièrement d'après le théorème d'égalité

des mesures, La fonction de répartition est donc un outil pour identifier la

loi d'une variable aléatoire. Sa définition est liée à une structure d'ordre;

elle sera donc en particulier bien manipulable lorsque la variable aléatoire

étudiée sera définie à l'aide d'opérations relatives à cet ordre (exemples :

sup, inf, max, min).

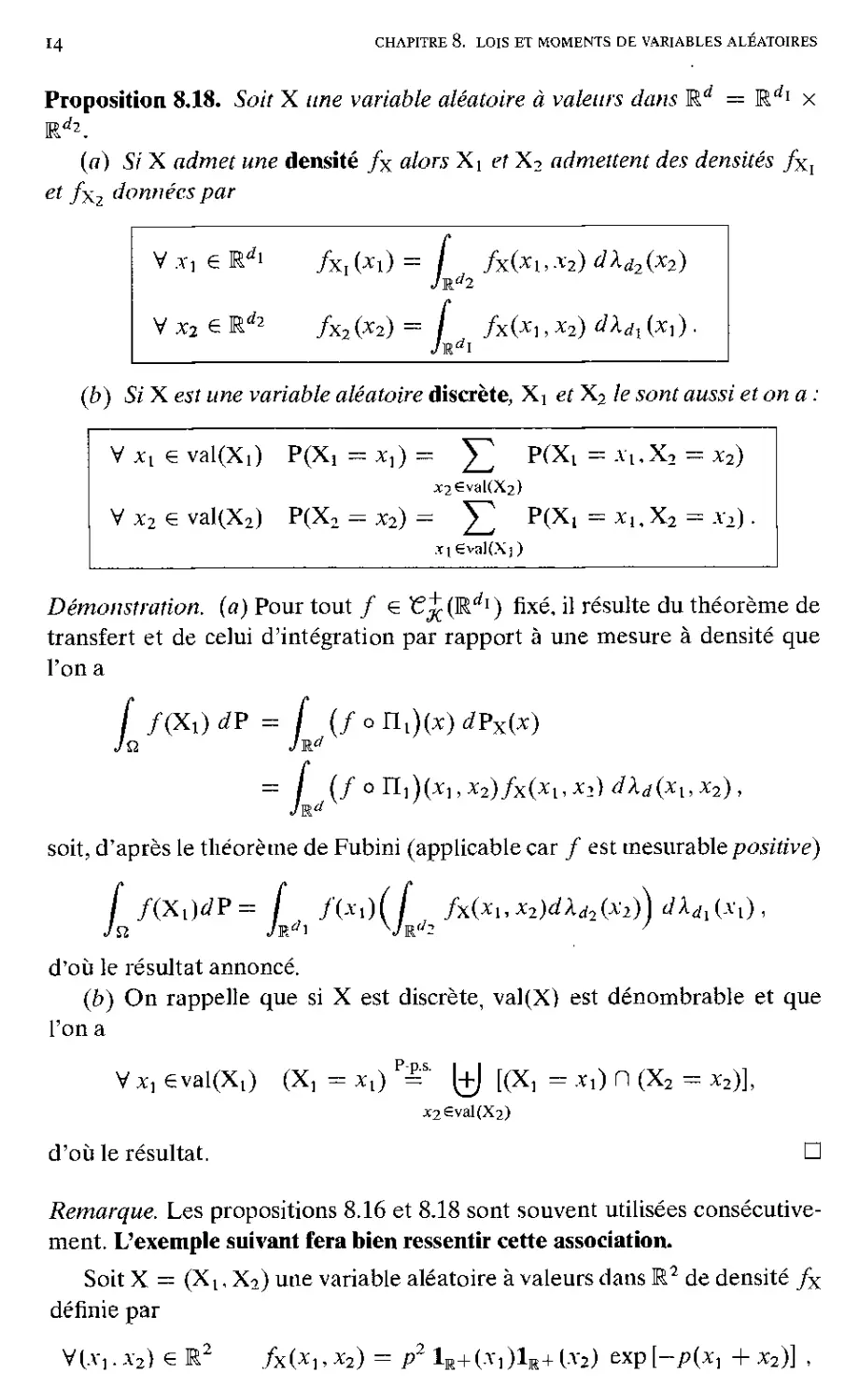

La proposition suivante permet d'obtenir la loi d'une variable aléatoire

transformée d'nne autre par nn difféomorphisme.

Proposition 8.16. Soit X une variable aléatoire à valeurs dans Rd et T un

difféomorphisme de Rd sur lui-même. Si X admet une densité fx, la variable

aléatoire Y = T o X, aussi notée T(X), admet une densité fy définie par

Vy € Rd fY(y) = | detCT-Vtv)! fx [T-l(y)] .

Démonstration. Pour tout / 6 if^(E'') fixé, il résulte du théorème de

transfert et de celui d'intégration par rapport à une mesure à densité que :

f fCt)d?= f /oTt»tfPx(x)= f foT{x)fx(x)dXd(x).

En faisant le changement de variables y — T(x) de Rd sur lui-même défini

par le difféomorphisme T, on obtient :

f f(Y)dP=[ f(y)\det(T~l)'(y)\ fx[T-l(y)] dXAy),

d'où le résultat. ?

Définition 8.17. Soit X une variable aléatoire à valeurs dans Rd = ]~[f=i ^

et soit TLi la projection canonique de Rd sur M.d'. La variable aléatoire

Xi — fi,- o X, à valeurs dans Erf', est appelée i-ième marginale de X

Les propositions suivantes permettent le calcnl de la loi des marginales.

Pour alléger l'écriture, nous ne les énonçons que pour k = 2, le cas général

se calquant sur ce cas particulier.

La variable aléatoire X admet donc une densité fx définie par

14 chapitre 8. lois et moments de variables aléatoires

V X] e R¿i

fxl (*l) = ^

f fx(Xy

x2) dXd

2(x2)

V x2 e R*2

fx2(x2) =

f fx(x1

x2) dXd

(b) Si X est une variable aléatoire discrète, Xi et X2 le sont aussi et on a :

Vx,e val(Xi)

P(Xi

X2€v'MX.2)

V x2 e val(X2)

P(X2

jqÊvaKXj)

Démonstration, (a) Pour tout / € '€jC(Rdï) fixé, il résulte du théorème de

transfert et de celui d'intégration par rapport à une mesure à densité que

l'on a

f f(X,)dP = f (/onJi^rfPxW

= / (/ o TíA(xux2)fx(xl,X2) dXd(xux2),

soit, d'après le théorème de Fubini (applicable car / est mesurable positivé)

f f(Xl)dP = f /(*,)(/ fx(xuX2)dXd2(x2))dXdl{xl),

d'où le résultat annoncé.

(b) On rappelle que si X est discrète, val(X} est dénombrable et que

l'on a

V X] eval(Xt) (X, - Xl) P-¦ (+J [(X, - x,) n (X2 - x2)],

j:2£val(X2)

d'où le résultat. ?

Remarque. Les propositions 8.16 et 8.18 sont souvent utilisées

consécutivement. L'exemple suivant fera bien ressentir cette association.

Soit X = (X t, X2) une variable aléatoire à valeurs dans R2 de densité fx

définie par

V(A"i . X2) € R2 /X(*l,X2) = P2 1M+(A-,)1je+1-V2) &Xp[-p(x] + X2)] ,

Proposition 8.18. Soit X une variable aléatoire à valeurs dans Rd = R1*1 x

(a) Si X admet une densité fx alors X{ et X2 admettent des densités fXï

et fxz données par

8.3- moments de variables aléatoires

15

où p > 0. On cherche la loi de la variable aléatoire Y = 2Xi — X2. Pour

cela, on introduit la variable aléatoire (Y,X2), transformée de X par le

difféomorphisme TdeR2 sur lui-même défini par T(,ïi . v2) = (2xr—x2,x2) ;

Y en est la première marginale. La variable aléatoire (Y,X2) admet la

densité f(Y,x2) définie par

V(y,X2) € M2 f(YX2)(y,X2) = l~ /x(^~,*2) .

La marginale Y admet donc la densité fY définie, pour tout y €

/y 00 =

/ f(Y,x2)(y>x2) dX{x2)

= f exp(—y ) j P !r+ (y + x2) 1r+ (x2) exp

p ( py\h°° r 3?

^-exp(-— / pexp'

^ ^ Z / Jmax(-v.01

3 exp^-—Jexp

par

dX(x2)

3pmax{— y,0)

soit

Vy €

/yOO = f L

(y)exp(-^r) + exp(y)lR*-0') .

8.3. Moments de variables aléatoires

Les moments d'une variable aléatoire, quand ils existent, sont des

paramètres qui donnent des renseignements sur la loi de cette variable aléatoire,

et quelquefois, même, la déterminent complètement. Avant de donner une

définition des moments et d'en étudier les propriétés, nous établissons les

inégalités de Holder et de Minkowski et en déduisons les premières

propriétés des espaces Xp.

Définition 8.19. Soit un réel p S 1; on note XP(Q,A,P) l'ensemble des

variables aléatoires X définies P-p.s., à valeurs dans M. ou M. et telles que

fQ \X\P dV < +oo. PouruntelXon note

On note X°°(Q, A, P) l'ensemble des variables aléatoires X définies P-p.s., à

valeurs dans R ou R et telles que sup {x | P(|X| > x) > 0} < -f-oo. Pour un

tel X on note

11X11«, = sup{x | P(|X| > x) > 0} = inf{.T | P(|X| > x) = 0}.

on dit alors que X est essentiellement (ou P-p.s.) bornée.

I6

chapitre 8. lois et moments de variables aléatoires

Remarque. Si X € £P(Q,A, P), X est P-p.s. finie.

SiX e X°°(Q,A,P), on a P-p.s. |X| $ RXII^.

Définition 8.20. Deux réels pet g sont conjugués s'ils sont strictement positifs

et satisfont à l'égalité ; ^ ^

- + - = 1 ;

p q

on a bien sûr p > 1 et q > 1. On définit de plus le conjugué de 1 comme étant

+ CO.

Lemme 8.21. Soient p et q deux réels conjugués différents de 1. Pour tous

a,b e "

I „D t_ff I

(8.5)

, ap bq

ab ^ — -I

P <7

Démonstration. La fonction x i-> — In x étant convexe sur on a, pour

tous x, y > 0 ^ ^ j

— ln( — + — ) ^ lnx ln y,

\p qS p q

soit

et donc :

ln

\p qJ

p q

Il suffit alors de choisir x et y tels que : a = xxlp et b — yllq pour obtenir

l'inégalité (8.5). ?

On déduit de ce lemme l'inégalité suivante :

Proposition 8.22 (Inégalité de Holder). Soient p et q deux réels conjugués,

finis ou non.

(a) Pour toutes variables aléatoires X, Y à valeurs dans E+ et définies

P-ps.; on a l'inégalité dans M.+ :

j XYdP^(J XpdPy/P(J y* d?y'9. (8.6)

(b) SiX e £P(Q,A, P) etY e £q(Q,A, P), le produitXY est integrable

et on a l'inégalité de Holder

liXYH, ^ 11X11, ||Y||ff

(8.7)

Si p — q = 2, cette inégalité implique l'inégalité de Schwarz :

LxYdp\<Lx2dp)"2(LY2dp)

1/2

8.3- moments de variables aléatoires

17

Démonstration. (a) Cas de variables aléatoires positives. Si p et q sont

finis ; si l'un des deux termes du membre de droite de l'inégalité (8.6) est nul,

par exemple le premier, alors X = 0 P-p.s. et on a alors fa XY dP = 0. Si

ces deux termes sont non nuls, il suffit de démontrer l'inégalité (8.6) lorsque

les deux termes du membre de droite sont finis. Il résulte du lemme 8.21 que

l'on a X Y IX* 1 Y*

<: —

M, ||Y||fl ^ p HXIIJ q HYIIJ '

ce qui, en intégrant, démontre l'inégalité (8.6).

Si p = 1 et q = +00 ; on a 0 ^ Y ^ llYj]^ P-p.s., et donc 0 ^ XY ^

X HYJloo P-p.s., ce qui, après intégration donne (8.6).

(b) Cas de variables aléatoires de signe quelconque. On applique

l'inégalité (8.6) aux valeurs absolues. ?

On en déduit l'inégalité de Minkowski.

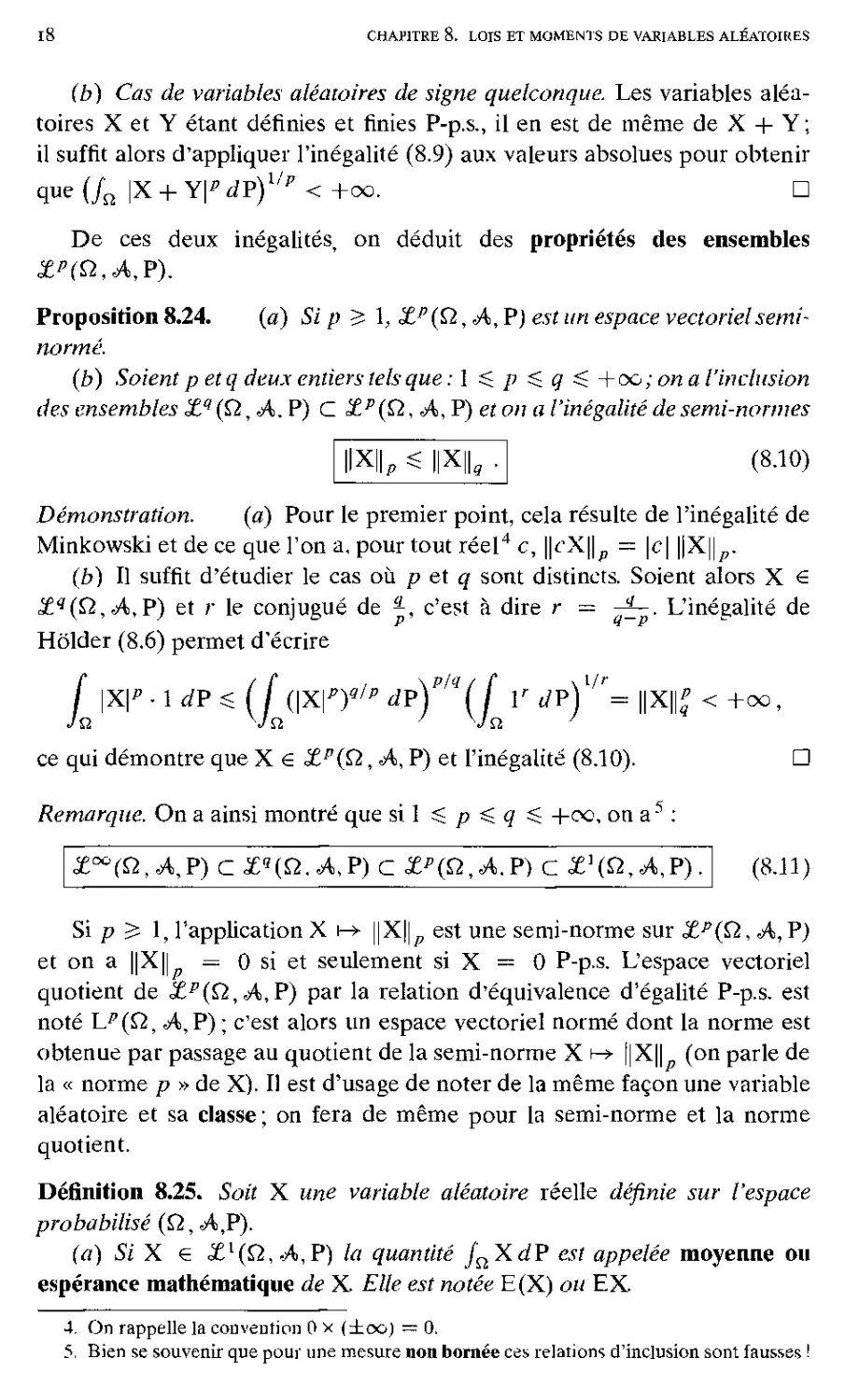

Proposition 8.23 (Inégalité de Minkowski). Soit un réel p > 1, fini ou non.

(à) Pour toutes variables aléatoires X, Y à valeurs dans E+ et définies

P-p.s., on a l'inégalité dans E+ :

(X+Y)p dP}1/P ^(J XpdPy/P + (J Yp dPjlP . (8.8)

(b) SiX € £P(Q,A,P) etY e £P(Q,A,P), la somme X + Y est dans

XP(Q, A,P) et on a l'inégalité de Minkowski :

IX + YILS ||X|L+||Y|

(8.9)

Démonstration. (a) Cas de variables aléatoires positives. Si p > 1 est

fini : par linéarité, on a,

[ (X+Y)pdP= f [(X+YJ^X] dP+ f [(X+Y)p~lY] dP.

En appliquant l'inégalité (8.7) à chacun des facteurs du membre de droite,

on obtient :

j (X + Y)p dP^ (X + Y)q{p'l) dV)l\J X? dP^j

+ (j (X+Y)*ip-V YpdP^'P.

Il suffit alors de remarquer que q(p — 1) = p.

Si p = +00, on a

|X + Y| ^ |X| + |Y| ^ ||Xj|? + ||Y||? P-p.s.,

et donc

l|X+Y||?S ||X||? + ||Yfl? ¦

i8

chapitre 8. lois et moments de variables aléatoires

(b) Cas de variables aléatoires de signe quelconque. Les variables

aléatoires X et Y étant définies et finies P-p.s., il en est de même de X + Y;

il suffit alors d'appliquer l'inégalité (8.9) aux valeurs absolues pour obtenir

que (fa |X + Y\p dP)Vp < +00. ?

De ces deux inégalités, on déduit des propriétés des ensembles

Zp(£i,A,P).

Proposition 8.24. (a) Si p 5 1, ZP(Q, A, P) est un espace vectoriel semi-

norme.

(b) Soient p et q deux entiers tels que : 1 ^ p $ q ^ + oc ; on a l'inclusion

des ensembles ZQ(Q,A.P) C £P(Q, A, P) et on a l'inégalité de semi-normes

|X||P^||X||9

(8.10)

Démonstration. (a) Pour le premier point, cela résulte de l'inégalité de

Minkowski et de ce que l'on a, pour tout réel4 c, ||^X||p = \c\ \\X\\p.

(b) Il suffit d'étudier le cas où p et q sont distincts. Soient alors X €

£q(Q,A,P) et r le conjugué de |, c'est à dire r = ^L. L'inégalité de

Holder (8.6) permet d'écrire

j \X\p-\dP^(J (\X\P)Q/P dP)P/q(J V JP)l/r= ||X||£ <+00,

ce qui démontre que X € ZP(Q, A, P) et l'inégalité (8.10). ?

Remarque. On a ainsi montré que si 1 $ p ^ q ^ +00, on a5 :

Z°°(Q,A,P) c £q(Q.A,P) c ZP(Q,A.P) c Z](ti,A,P). (8.H)

Si p ^ 1, l'application X \\X\\p est une semi-norme sur ZP(Q, A, P)

et on a \\X\\p = 0 si et seulement si X = 0 P-p.s. L'espace vectoriel

quotient de ZP(Q,A,P) par la relation d'équivalence d'égalité P-p.s. est

noté Lp (Q, A, P) ; c'est alors un espace vectoriel norme dont la norme est

obtenue par passage au quotient de la semi-norme X h» \\X\\p (on parle de

la « norme p » de X). Il est d'usage de noter de la même façon une variable

aléatoire et sa classe ; on fera de même pour la semi-norme et la norme

quotient.

Définition 8.25. Soit X une variable aléatoire réelle définie sur l'espace

probabilisê (Q, A,P).

(a) Si X € Zl(Q, A,P) la quantité J^XdP est appelée moyenne ou

espérance mathématique de X. Elle est notée E(X) ou EX.

4. On rappelle la convention 0 x (±00) = 0.

5, Bien se souvenir que pour une mesure non bornée ces relations d'inclusion sont fausses !

8.3. moments de variables aléatoires

19

(b) Si X € Xa(Q, A, P), où a > 0, la quantité JQ Xa dP est appelée

moment d'ordre a de X. C'est donc aussi la moyenne E(Xa) de la variable

aléatoire Xa. En particulier, si a > 1 et si X e Xa(Q, A, P), la quantité

E [(X — EX)"] est appelée moment centré d'ordre a de X.

(c) Si a = 2, le moment centré d'ordre 2 est appelé variance de X et noté

ax. Sa racine carrée positive ox est appelée écart-type de X

Proposition 8.26. E est une forme linéaire (continue) sur l'espace vectoriel

&(Q,A,P).

Démonstration. C'est un résultat de la théorie de l'intégration (prop. A.21).

Définition 8.27. Si X e £1(Q,A, P), la variable aléatoire X = X - EX

est appelée variable aléatoire centrée associée àX. SiX e X2(Q, A, P), la

variable aléatoire ^ (resp. ~ ) est appelée variable aléatoire réduite (resp.

centrée réduite) associée à X.

Remarque. 1. Toutes ces définitions ne présument en rien de la forme de la

loi de la variable aléatoire X; elles recouvrent en particulier les définitions

données dans les chapitres précédents pour les variables aléatoires discrètes et

à densité (tome 1 ). Nous renvoyons donc le lecteur à ces chapitres, tant pour

les résultats classiques que pour les exercices concernant de telles variables

aléatoires.

2. Il résulte des relations d'inclusion (8.11) que si une variable aléatoire

admet un moment d'ordre p > 1, elle admet un moment de tout ordre 1

et^ p.

Calcul des moments

Si X e Xa(Q, A, P), le théorème de transfert donne :

En particulier,

- si X est une variable aléatoire discrète, puisqu'alors la loi de X vérifie

?

o

o

Px= E p(x = *h

x e val (X)

il vient :

E(X") = J2 *a P(X = '

xeval(X)

20

chapitre 8. lois et moments de variables aléatoires

- si X est une variable aléatoire à densité fx, puisqu'alors la loi de X

vérifie Px = fx ¦ ^> il vient, par le théorème d'intégration par rapport

à une mesure à densité :

E(X*) = f xafx(x)dX(x).

Jr

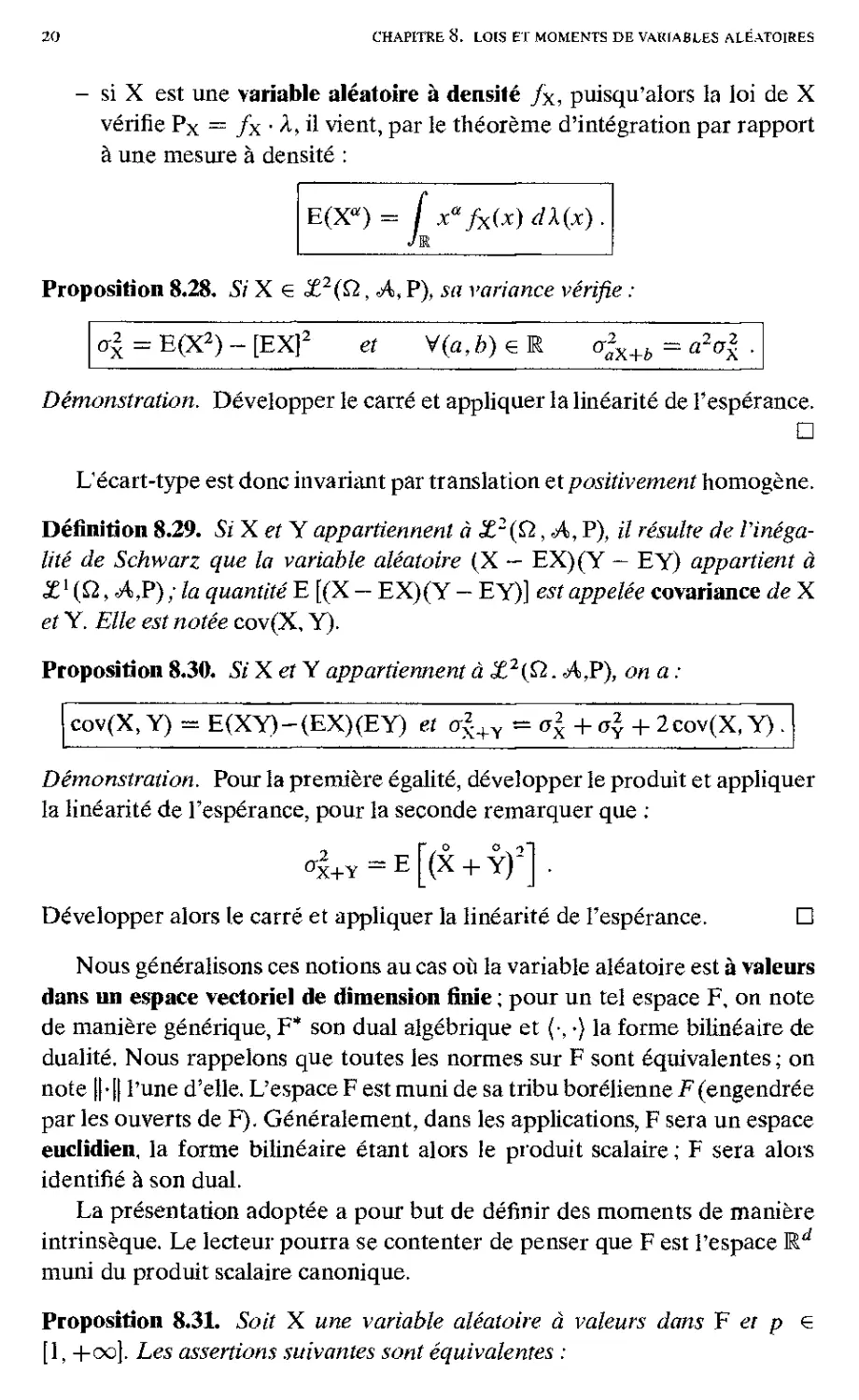

Proposition 8.28. Si X € X2(Q, A, P), sa variance vérifie :

ax = E(X2) - [EX]2 et V(a,b) € R o2aX+b = a2ax .

Démonstration. Développer le carré et appliquer la linéarité de l'espérance.

?

L'écart-type est donc invariant par translation et positivement homogène.

Définition 8.29. Si XetY appartiennent à £2(Q, A, P), il résulte de Vinêga-

lité de Schwarz que la variable aléatoire (X — EX)(Y — EY) appartient à

%1 (Q, <A,P) ; la quantité E [(X - EX)(Y - EY)] est appelée covariance de X

et Y. Elle est notée cov(X, Y).

Proposition 8.30. Si XetY appartiennent à Z2(Q. A,P), on a :

cov(X,Y) = E(XY)-(EX)(EY) et a2+Y = ax + o2 + 2cov(X, Y) .

Démonstration. Pour la première égalité, développer le produit et appliquer

la linéarité de l'espérance, pour la seconde remarquer que ;

^x+Y-E[(X+Y)2" .

Développer alors le carré et appliquer la linéarité de l'espérance. ?

Nous généralisons ces notions au cas où la variable aléatoire est à valeurs

dans un espace vectoriel de dimension finie ; pour un tel espace F, on note

de manière générique, F* son dual algébrique et (¦, •) la forme bilinéaire de

dualité. Nous rappelons que toutes les normes sur F sont équivalentes; on

note ||-|| Tune d'elle. L'espace F est muni de sa tribu borélienne F (engendrée

par les ouverts de F). Généralement, dans les applications, F sera un espace

euclidien, la forme bilinéaire étant alors le produit scalaire ; F sera alors

identifié à son dual.

La présentation adoptée a pour but de définir des moments de manière

intrinsèque. Le lecteur pourra se contenter de penser que F est l'espace M.d

muni du produit scalaire canonique.

Proposition 8.31. Soit X une variable aléatoire à valeurs dans F et p €

[1, +00]. Les assertions suivantes sont équivalentes :

8.3- moments de variables aléatoires

21

(i) HXH 6 £p(n,A,~P)

(ii) Vx* 6F* {X,x*} eXp(Q,A,P).

Démonstration. Si F* est muni de la norme définie par

|[x*|| = sup {*,**>,

H*ll€i

l'implication (i) donne (ii) résulte de l'inégalité :

Vx* eF* \{X,x*)\ ^ \\X\\\\X*\\

Pour l'implication inverse, soit (e/)i=i,,„,rf tine base de F et (e*);=i,la

base duale dans F* ; on a ;

d

liX||^|{X,e*)||M .

i = i

La fonction x xp étant croissante sur E+, il suffit d'appliquer l'inégalité

de Minkowski. ?

Notation. Zp(Q,A,P) est l'espace vectoriel des variables aléatoires à

valeurs dans F telles que ||X|| e XP(Q, A, P).

Définition 8.32. Soit X e <£F(£2, A, P). La forme linéaire sur F* : .x* h->-

/fi {X, .y*) dP est appelée moyenne de X et notée E(X). Identifiant F et son

bidual, c'est à dire le duai algébrique^ de F*, la moyenne E(X) est Tunique

élément de F qui satisfait à :

Vx* eF* (E(X),x*) = E{X,x*

(8.12)

Remarque. 1. On note de la même façon l'opérateur moyenne sur

A,P) et £^(Q,A,P); si F == E, ils coïncident. L'opérateur E est

encore linéaire sur <£p(£2, A, P).

2. Si F — Md muni de sa base canonique, il résulte de (8.12) que E(X) est

le vecteur de Rd de ie composante E(X,).

Pfoposition 8.33. Soit X 6 XF(£2, <A. P); soient A e £(F, G) et b € G, ow

G w/7 awfre espace vectoriel de dimension finie. Alors la variable aléatoire

AX + b e JEjj(fi,.A,P)ei:

E(AX + 6) — A E(X) + b .

6. Le fait que F soit de dimension finie garantit que F et son bidual sont isomorphes ; ce n'est

plus le cas en dimension infinie. Dans ce cas, ]a définition de la moyenne peut poser problème.

22

chapitre 8. lois et moments de variables aléatoires

Démonstration. On a

IIAX + èll $ ||A|| [|X|| + ,

ce qui démontre que AX + 6 € #¿(£2, A P). De plus, en utilisant la

définition du transposé de A, on a

V/ e G* {E(AX + b),y*} — E (AX + b, y*}

= E[(X,A*y*) + (b,y*)]

=- (EX,A*j/*) + {b, y*)

= (AE(X) +b,y*} ,

ce qui démontre le résultat.

?

Définition 8.34. SoitX e £p(£2,AP)- La forme quadratique positive sur

F* : je* fQ{X — EX, x*)2 dP est appelée variancedeX et notée ox(:). Elle

est associée de manière bijective à l'opérateur linéaire auto-transposé positif

Ax € X(F*,F) par la relation :

Wx* eF* {Axx*,x*) =cr*(x*).

Cet opérateur est appelé opérateur d'auto-covariance de X. Si

est une base de F et (e*),-=i5...^ la base duale dans F*, la représentation

matricielle Cx de l'opérateur Ax dans ces bases est appelée matrice des

covariances de X. Elle vérifie :

Vi,j=i,...,d (Cx)u = cov((X, ef), (X, e])) .

Remarque. Si F = Rd est muni de sa base canonique, Cx est la matrice

symétrique positive d x d :

Cv -

2

cov(Xy,X()

cov(X(-,Xj)

>Xd/

Proposition 8.35. Soit X e £2(£2, A P) ; soient A e £(F, G) et b e G, oii

G est un aiifre espace vectoriel norme de dimension finie. Alors la variable

aléatoire AX e AP) on a

A

AX+Ô

= AAXA

8.3- moments de variables aléatoires

23

Cax+6 = ACxA* .

Démonstration. On a

|AX + è||2^-(||A|

1X1

l*l|2).

ce qui démontre que AX + b e £q(Q, A,P). De plus, en utilisant la

définition du transposé de A et la proposition 8.33, on a

Vy*eG* (AAX+by*,y*) = E[(AX,y*)2]

= E[{X,AV)]2

- (AxA*y*,A*y*>

- (AAxA*y*,y*) ;

par bilinéarisation, il en résulte que ;

Vx*,y* eG* (Aax+6**,/"> - (AAxA*x*,y*) ,

ce qui démontre le résultat. ?

Nous donnons deux inégalités classiques, bien que grossières, qui

permettent de donner quelques renseignements sur la concentration des valeurs

prises par une variable aléatoire, en particulier autour de sa moyenne ; elles

sont numériquement très mauvaises, ce qui ne surprend pas quand on étudie

leur démonstration. Ces inégalités servent surtout à démontrer des

convergences en probabilité (voir chapitre 10).

Proposition 8.36 (Inégalité de Markov). SiX e Zl(Q,A,P) est positive, on

a, pour tout s > 0 ;

P(X £ e)

EX

et a fortiori

P(X > s) ^

EX

En conséquence, si X e X^(Q, A, P), on a, pour tout s > 0 :

P(||X|| > e)

<

EHXI

Démonstration. Si X e X1 (Q, A, P) est positive, soit D — {X 5 e}. On a les

minorations successives :

EX = / X dp £ / XdP £ eP(D) ,

ce qui s'écrit, dans le cas de matrice de covariance :

24

chapitre 8. lois et moments de variables aléatoires

d'où la première inégalité ; la seconde résulte alors de l'inclusion (X > e) C

(X=5fi).

Si X G £F(Q,A,V), il suffit d'appliquer l'inégalité précédente à la

variable aléatoire positive ||X||. ?

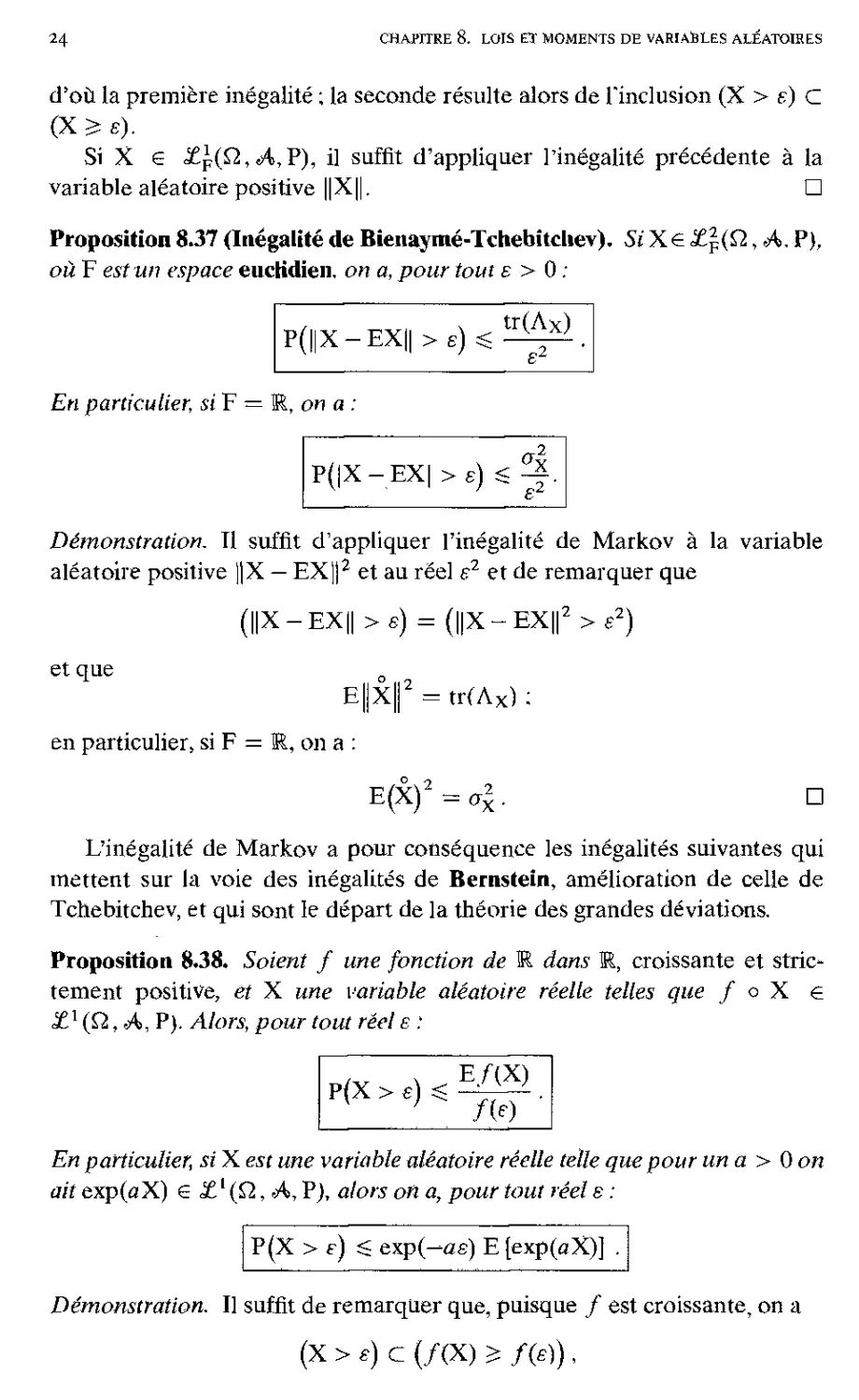

Proposition8.37(Inégalitéde Bienaymé-Tchebîtcliev). Si' Xe£F(&, A. P),

où F est un espace eucKdien, on a, pour tout e > 0 ;

P(||X-EX|| > e)

<

tr(Ax)

En particulier, si F — E, on a :

P(|X-EX| > e)

Démonstration. Tl suffit d'appliquer l'inégalité de Markov à la variable

aléatoire positive ]|X — EX]j2 et au réel e2 et de remarquer que

|X-EX||>e) = (||X-EXf>£2)

et que

E||X|| =tr(Ax):

en particulier, si F = E, on a :

E(X)2 = aJ.

?

L'inégalité de Markov a pour conséquence les inégalités suivantes qui

mettent sur la voie des inégalités de Bernstein, amélioration de celle de

Tchebitchev, et qui sont le départ de la théorie des grandes déviations.

Proposition 8.38. Soient f une fonction de E dans E, croissante et

strictement positive, et X une variable aléatoire réelle telles que f o X e

£l (Q, A, P). Alors, pour tout réel e :

P(X > e)

E/(X)

m

En particulier, si X est une variable aléatoire réelle telle que pour un a > 0 on

ait exp(oX) G £l(Q,A, P), alors on a, pour tout réel s :

P(X > e) <= exp(^ûe) E [exp(oX)] .

Démonstration. Il suffit de remarquer que, puisque / est croissante, on a

(X > e) C (/(X) =s f(B)),

8.3. moments de variables aléatoires

25

et donc : ,

P(X>e);SP[/(X) =s/(*)].

L'inégalité de Markov (avec inégalité large) appliquée à la variable aléatoire

/(X) et au réel positif f(s) permet de conclure. La seconde inégalité

s'obtient à partir de la première en prenant f(x) = exp(ax). ?

On introduit la notion de coefficient de corrélation qui, comme on le

verra ensuite permet de « mesurer » une certaine liaison entre des variables

aléatoires.

Définition 8.39. Soient X et Y e Z2(Q,A,P) de variance non nulle. On

appelle coefficient de corrélation deXetY le réel

cov(X, Y)

px.y — ^—

CrxOY

Proposition 8.40. Soient X et Y G Z2{Q., A, P) de variance non nulle; leur

coefficient de corrélation px,y possède les propriétés suivantes ;

(a) \px,y\ ^ 1 ;

(b) Pour que \px,y\ = l, il faut et il suffit qu'existent trois réels a, b,c non

tous nuls tels que :

P(aX + bY + c = 0) = 1 .

Démonstration. (à) L'inégalité de Schwarz permet d'écrire :

|E(XY)| ^E|XY| $(EX )5(EY y ,

ce qui démontre l'inégalité annoncée.

r 0 0 T2

(b) Si Ipx.yÎ — 1. Ie polynôme du second degré en A, E[X + AYJ , a

son discriminant réduit nul et admet donc une racine double A0 ; on a alors

E[X + XqY]2 = 0. Il en résulte que P(X + A0 Y = 0) = 1.

Réciproquement, supposons qu'existent trois réels a,b,c non tous nuls tels

qUe P(aX + bY + c = 0) = 1. (8.13)

Si c 7^ 0, û et 6 sont différents de 0 ; en effet, si par exemple a = 0, on a

alors P(Z>Y + c = 0) = 1 et donc ofY+c = ao = 0, soit encore Z>2aY — 0 et

donc b = 0, ce qui est impossible d'après (8.13). Dans ce cas on a

P(X = «Y + 0) = 1 , (8.14)

où a 7e 0.

Si c = 0, on a <a 9e 0 ou Z> ^ 0. Si par exemple a ^ 0, l'égalité (8.14) est

encore satisfaite avec /3 = 0 (si c'était è, on ferait un calcul analogue).

Dans ces deux cas on a donc

cov(X, Y) = E[(ofY)Y] — ot <jy et <x£ = a<JY+tf = «2<*y -

26

chapitre 8. lois et moments de variables aléatoires

ce qui donne px,Y —

|-,et donc: | px, y I = 1.

?

Y

Problème de régression linéaire

Les variables aléatoires X et Y e X2(Q, A,, P) étant données, on cherche

une « meilleure » approximation de Y comme fonction affine de X au sens

des moindres carrés, à savoir une solution en le couple (a,b) e E2 du

problème de minimisation

Ce problème est appelé, improprement d'ailleurs, problème de régression

linéaire.

Il n'y a formellement pas un mot à changer à l'analyse que nous avons

faite au tome 1 pour les variables aléatoires discrètes. Nous redonnons

toutefois la résolution de ce problème dans ce cadre général. On a :

Pour tout a fixé, cette quantité est minimum pour b = ba — EY — aEX.

Eeste à minimiser en a la quantité

<b{a,ba) = o\~2acov(X,Y) + a2ox ;

une valeur a minimisant ce polynôme du second degré est l'unique solution

de l'équation

inf(3>(u,ò) I (a,b) el2),

où

®(a,b) = E [Y - (<*X + &)]2 .

3>(a,6) =E[Y-aX + (EY-tfEX-6)]2

= E[Y - aXf + [EY - aEX - bf

(y-EY) - px>Y -i(jc-EX) = 0

est appelée droite de régression linéaire de Y en X. La « meilleure »

approximation de Y comme fonction affine de X au sens des moindres carrés

est

8-3- moments de variables aléatoires

27

EY + px,Y^(X-EX)

et on a P[(X, Y) e D] = 1 si et seulement si $(â, b$ = 0.

Cas particulier. Si la variable aléatoire est de loi uniforme sur l'ensemble des

n points du plan {(Xi,yt)}i^i^„ alors $(a, b) = J YJ^=1 [vl- - (a.tj + &)]2.

On retrouve la droite d'approximation des moindres cariés des physiciens.

(Exercice : déterminer alors l'équation de la droite D).

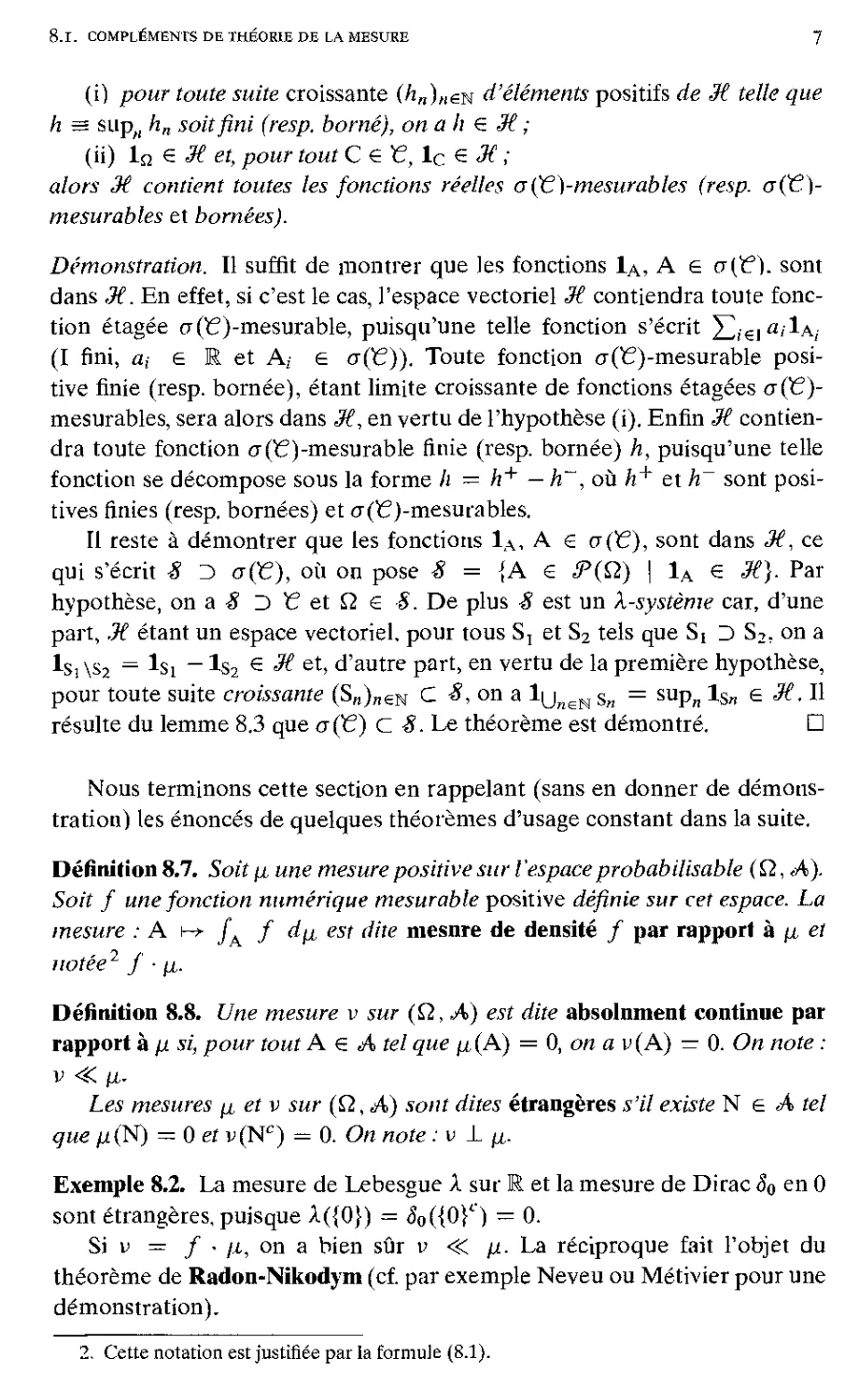

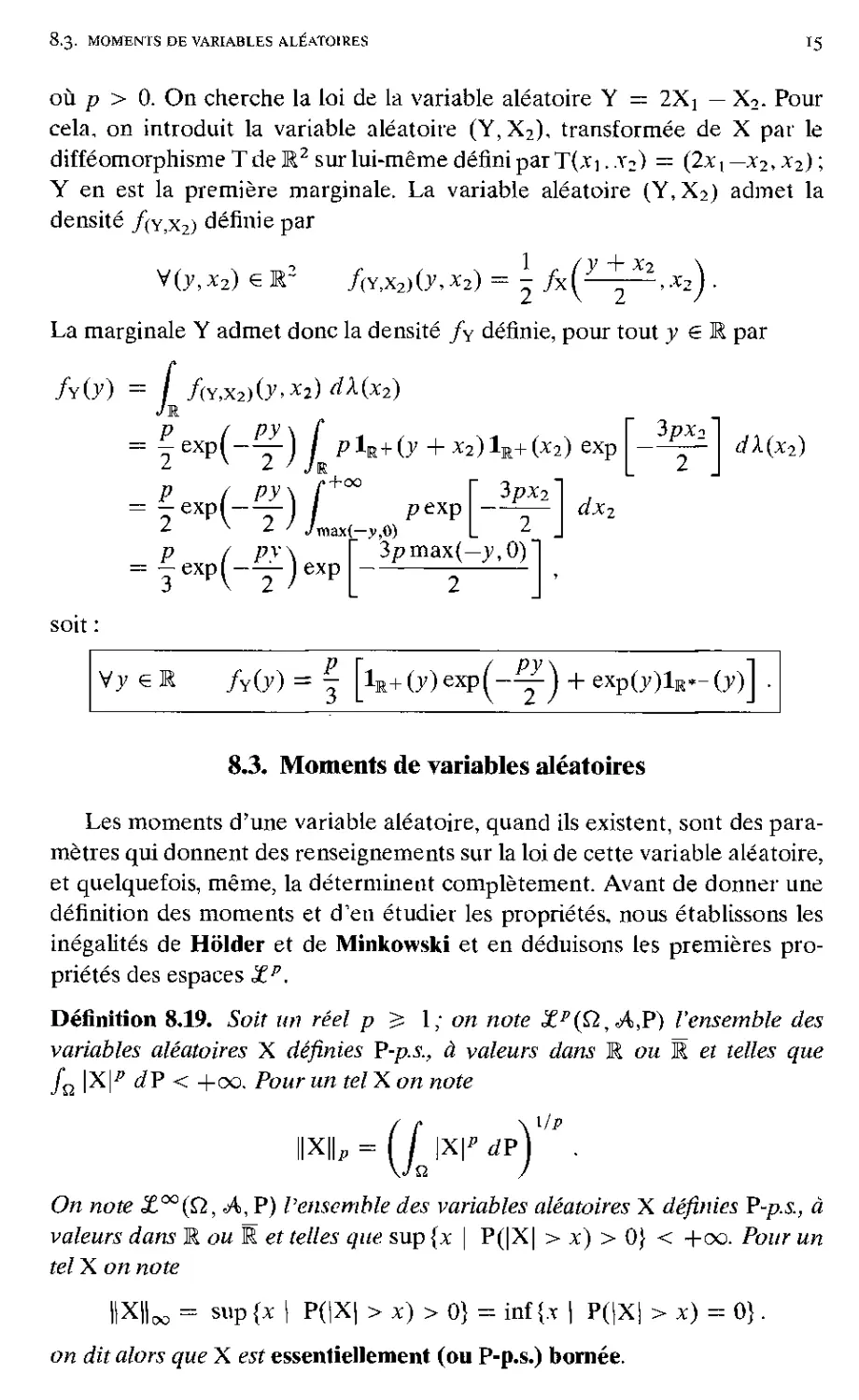

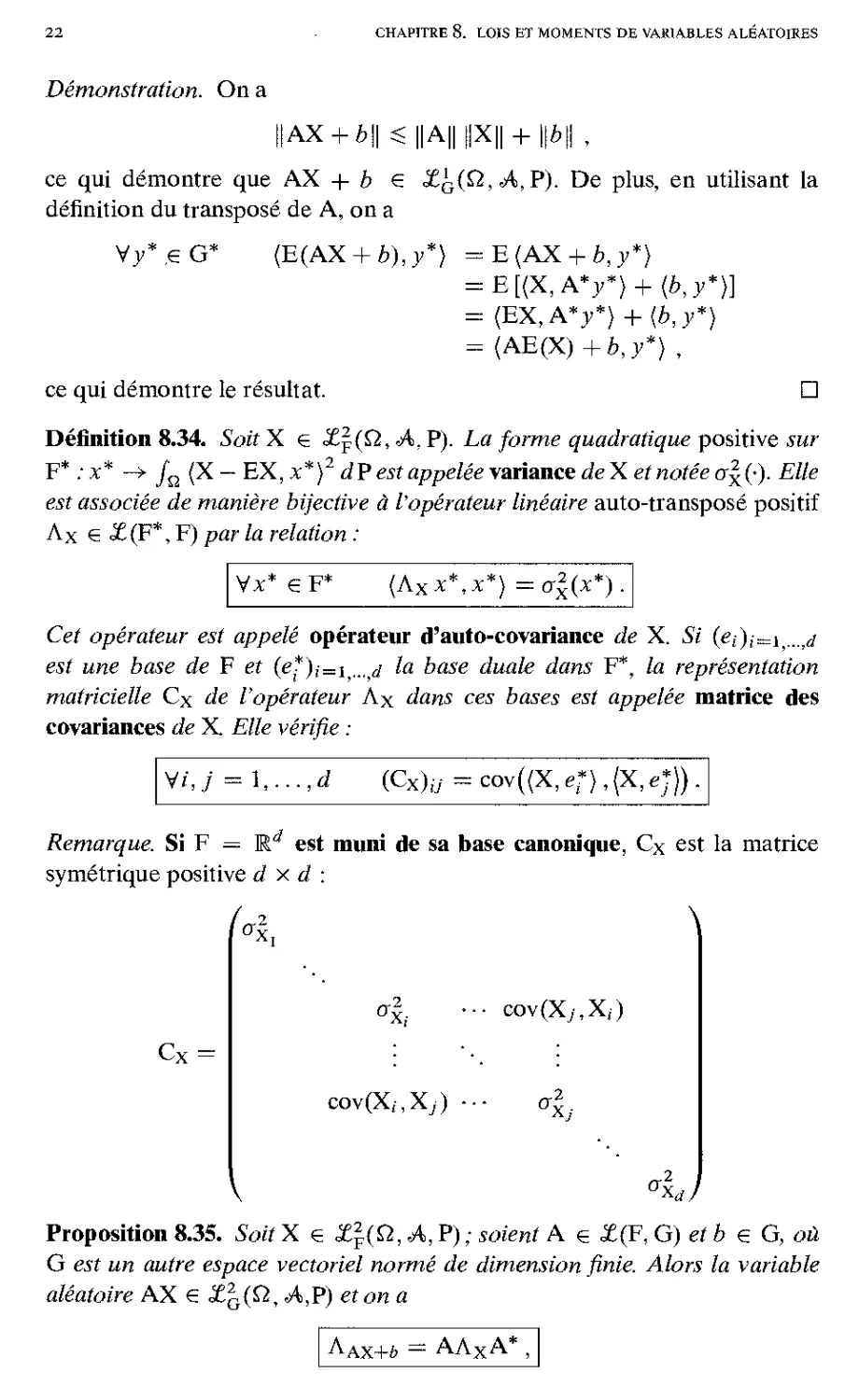

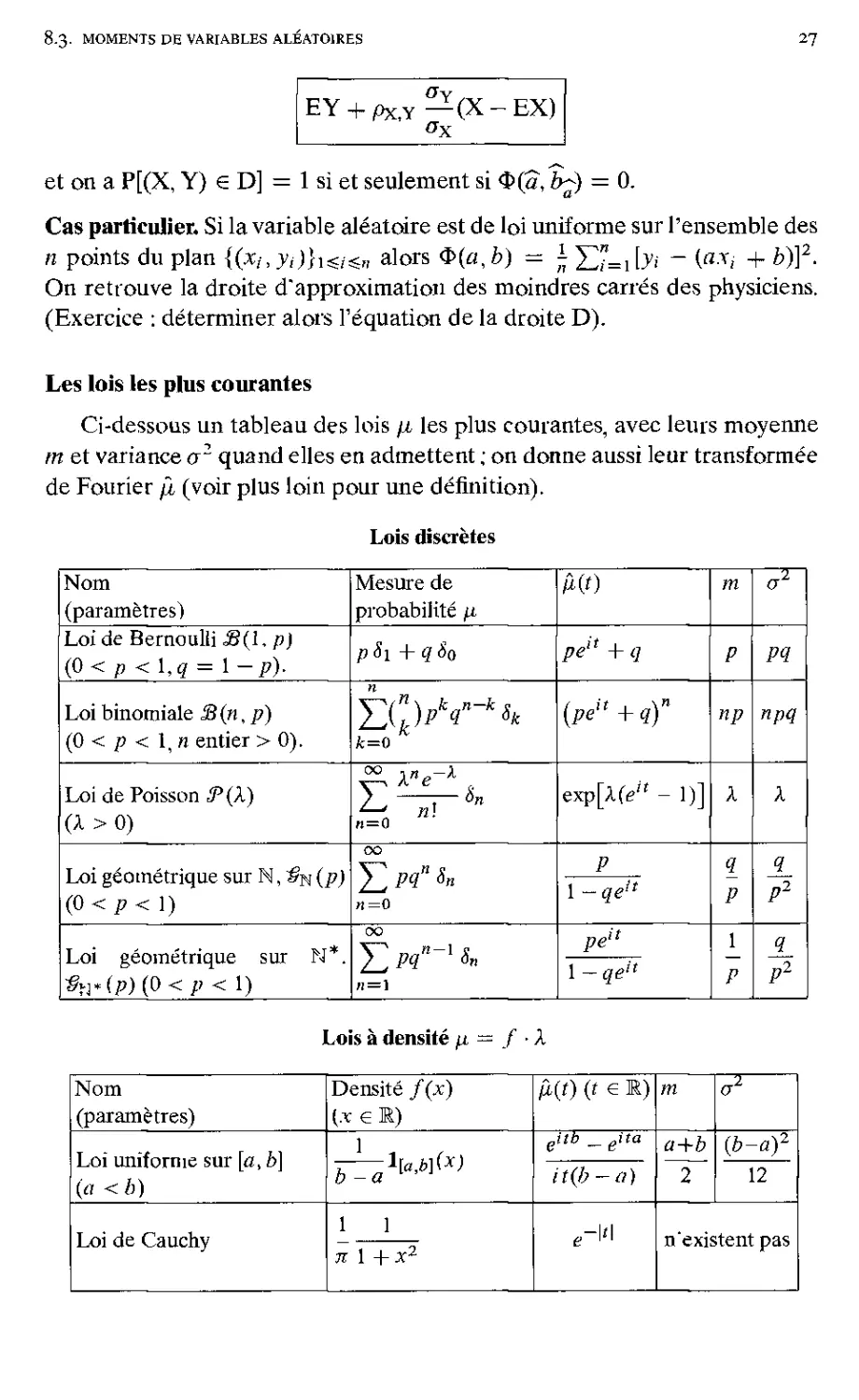

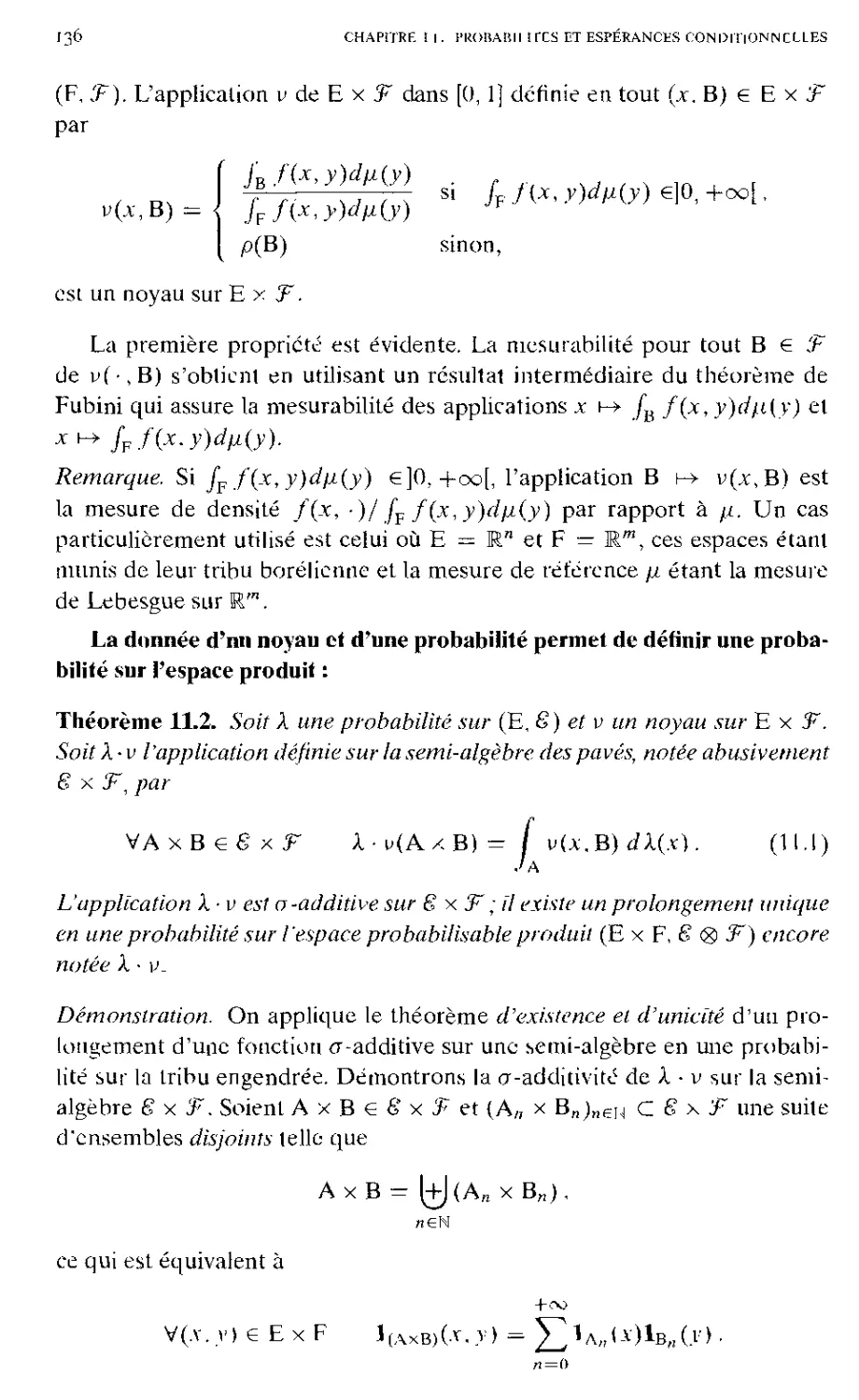

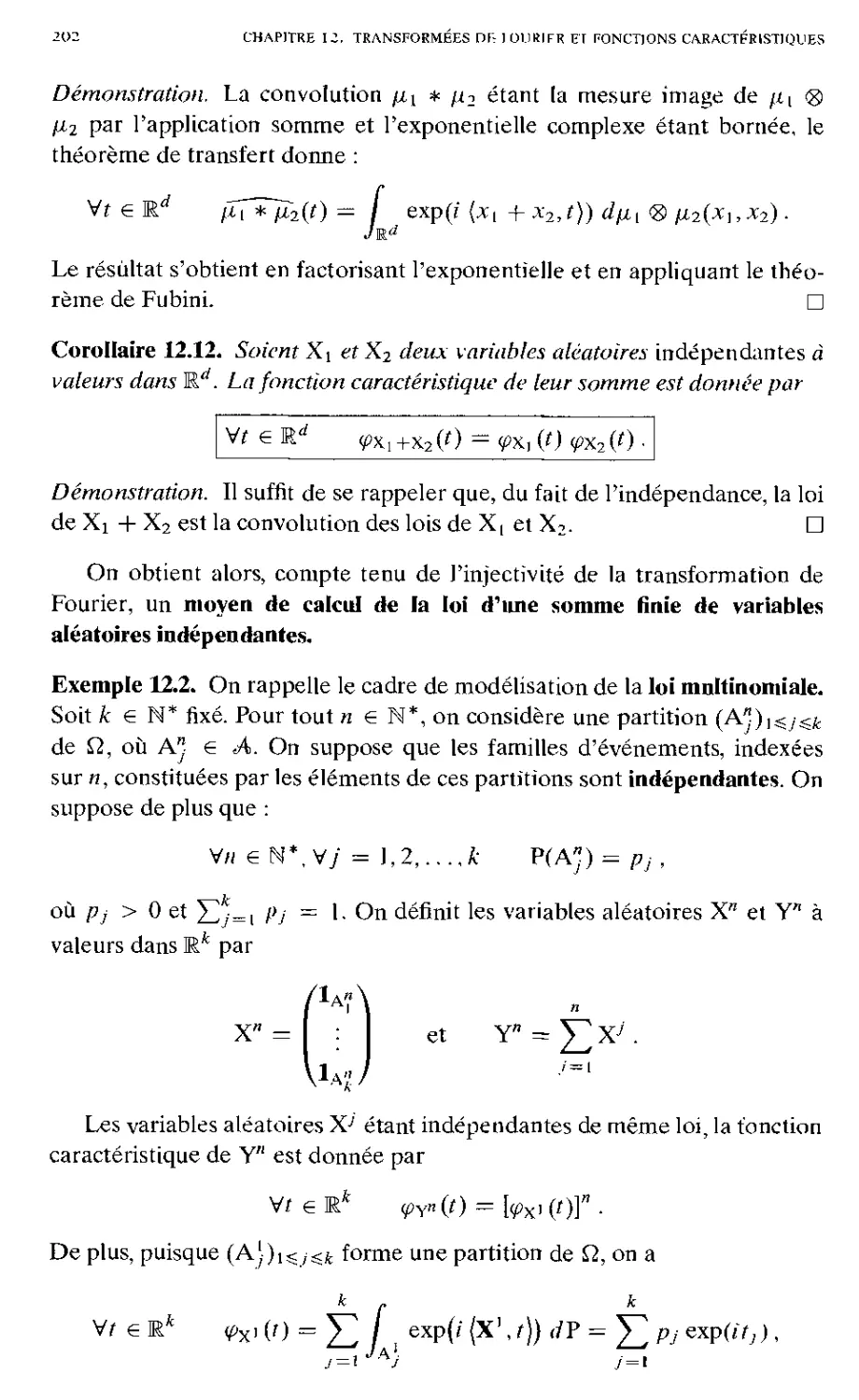

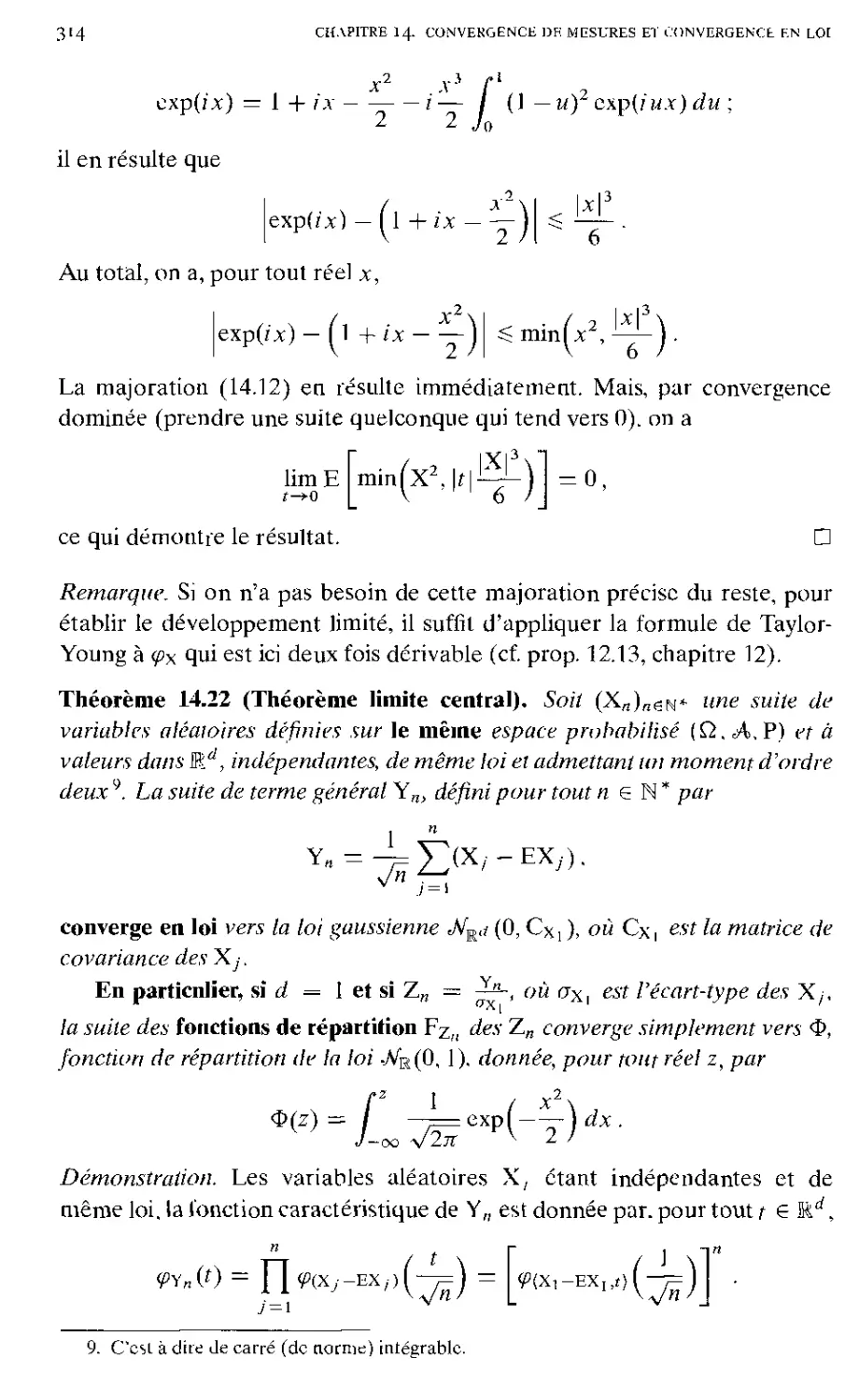

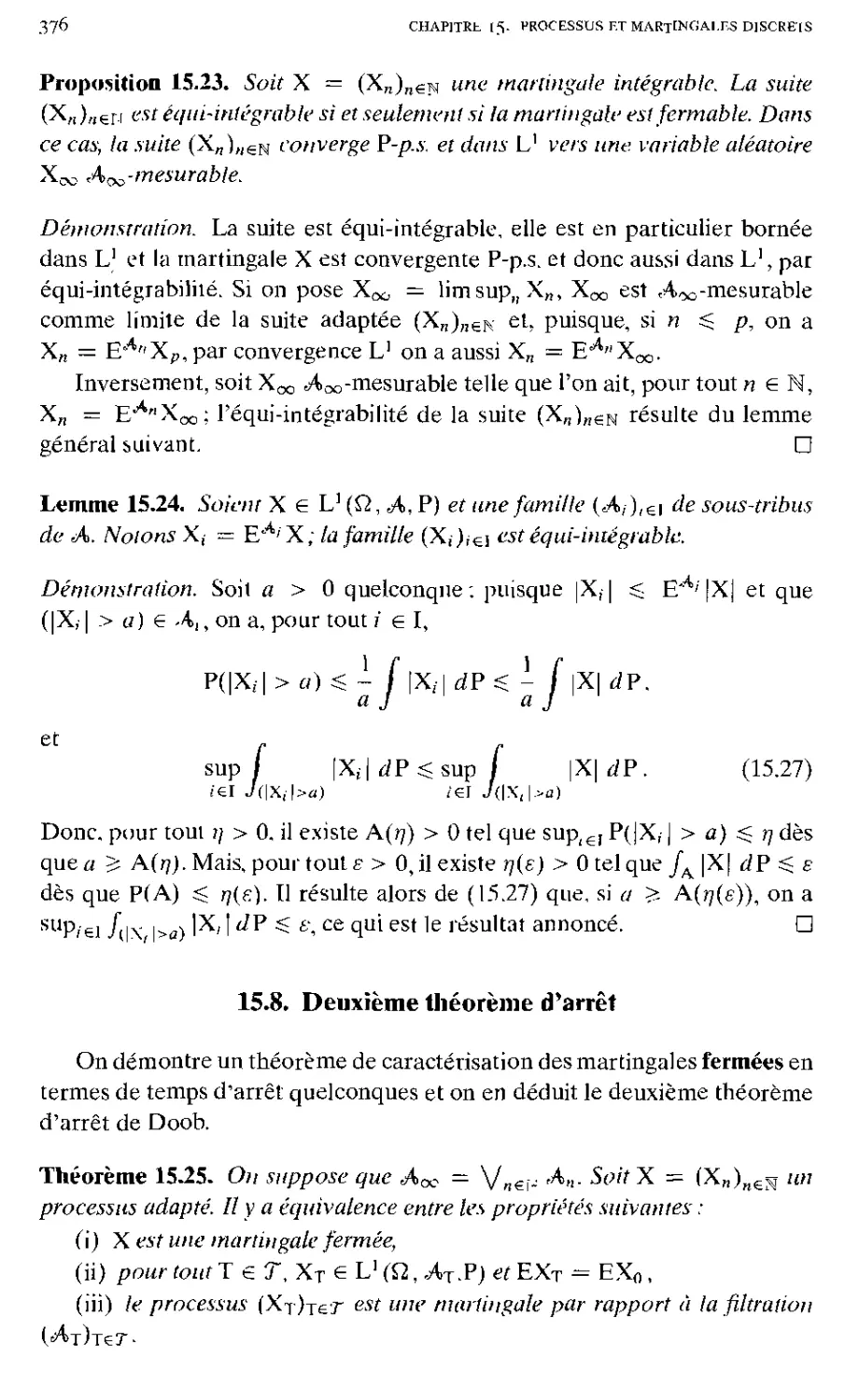

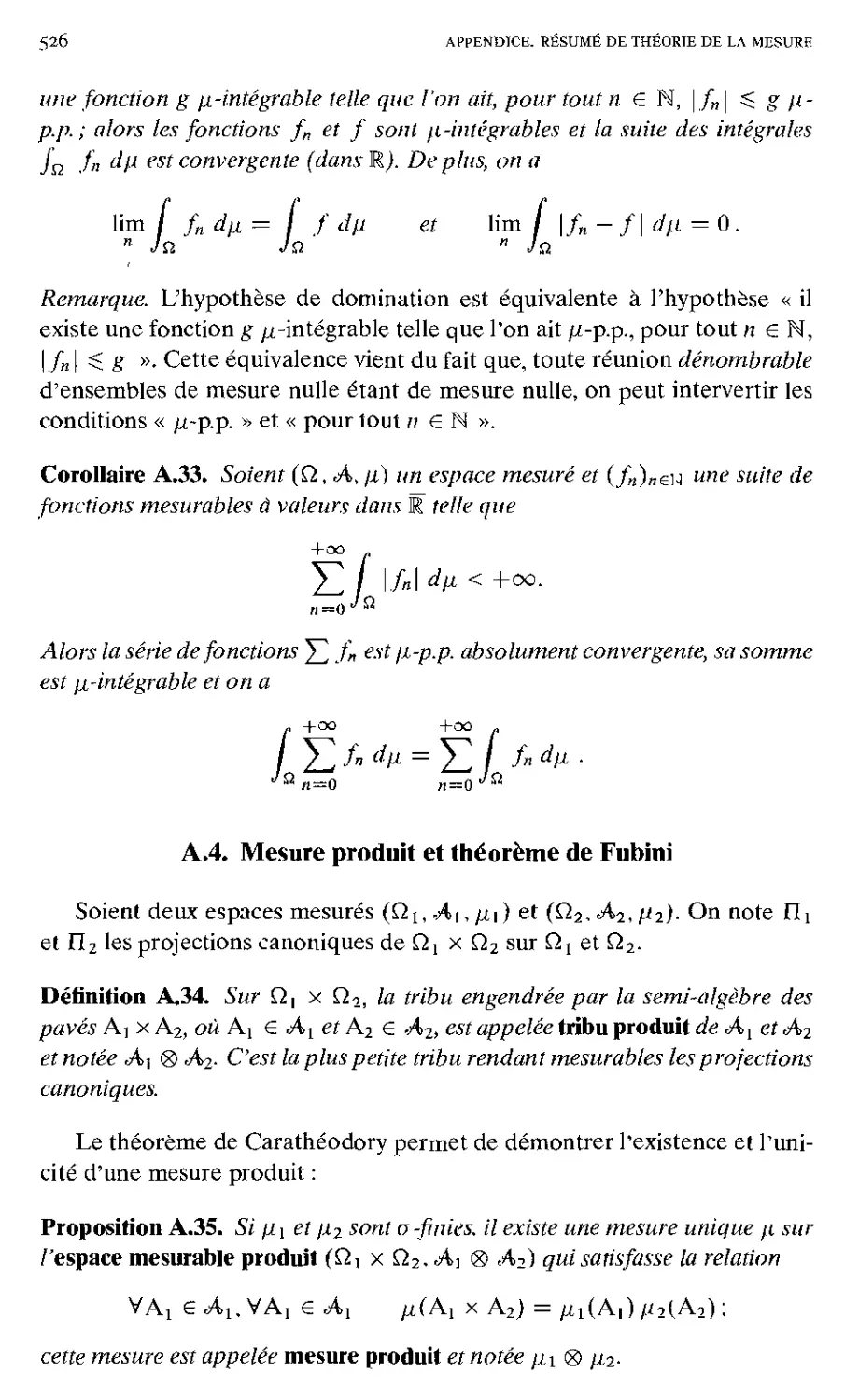

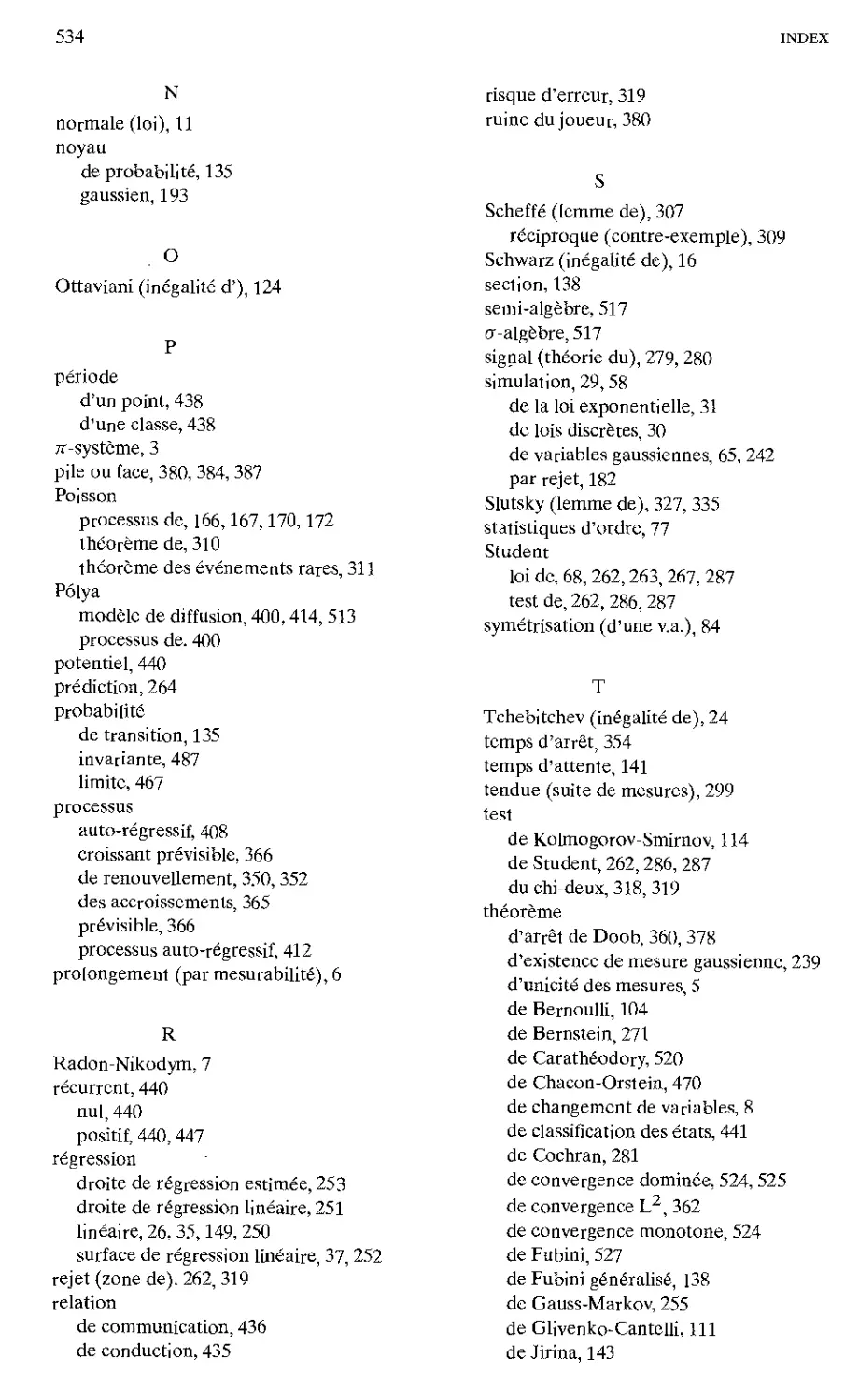

Les lois les plus courantes

Ci-dessous un tableau des lois fi les plus courantes, avec leurs moyenne

m et variance a2 quand elles en admettent ; on donne aussi leur transformée

de Fourier p, (voir plus loin pour une définition).

Lois discrètes

Nom

(paramètres)

Mesure de

probabilité p

ß(t)

m

a1

Loi de Bernoulli «8(1, p)

(0<p< Uq = \-p).

pSi+qSo

peif + q

P

pq

Loi binomiale B(n, p)

(0 < p < 1, n entier > 0).

k=0

{peU+q)n

np

npq

Loi de Poisson

(A>0)

E , *•

t—1 ni

n=a

exp[X(eu - 1)]

X

X

Loi géométrique sur N, ^(p)

(0<p<\)

00

P

1

P

1

P2

Loi géométrique sur N*.

$n*<P) (0 </><!)

oo

peil

1 - qeil

1

P

1

P2

Lois à densité p =¦ f ¦ X

Nom

(paramètres)

Densité f(x)

{x e R)

ß(t) (t e R)

m

a1

Loi uniforme sur [a, b]

(a < b)

eitb -eita

a+b

(b-a)2

, 1 «,6 ]\x)

b - a

it(b-a)

2

12

Loi de Cauchy

1 1

71 1 +X2

e-v\

n'existent pas

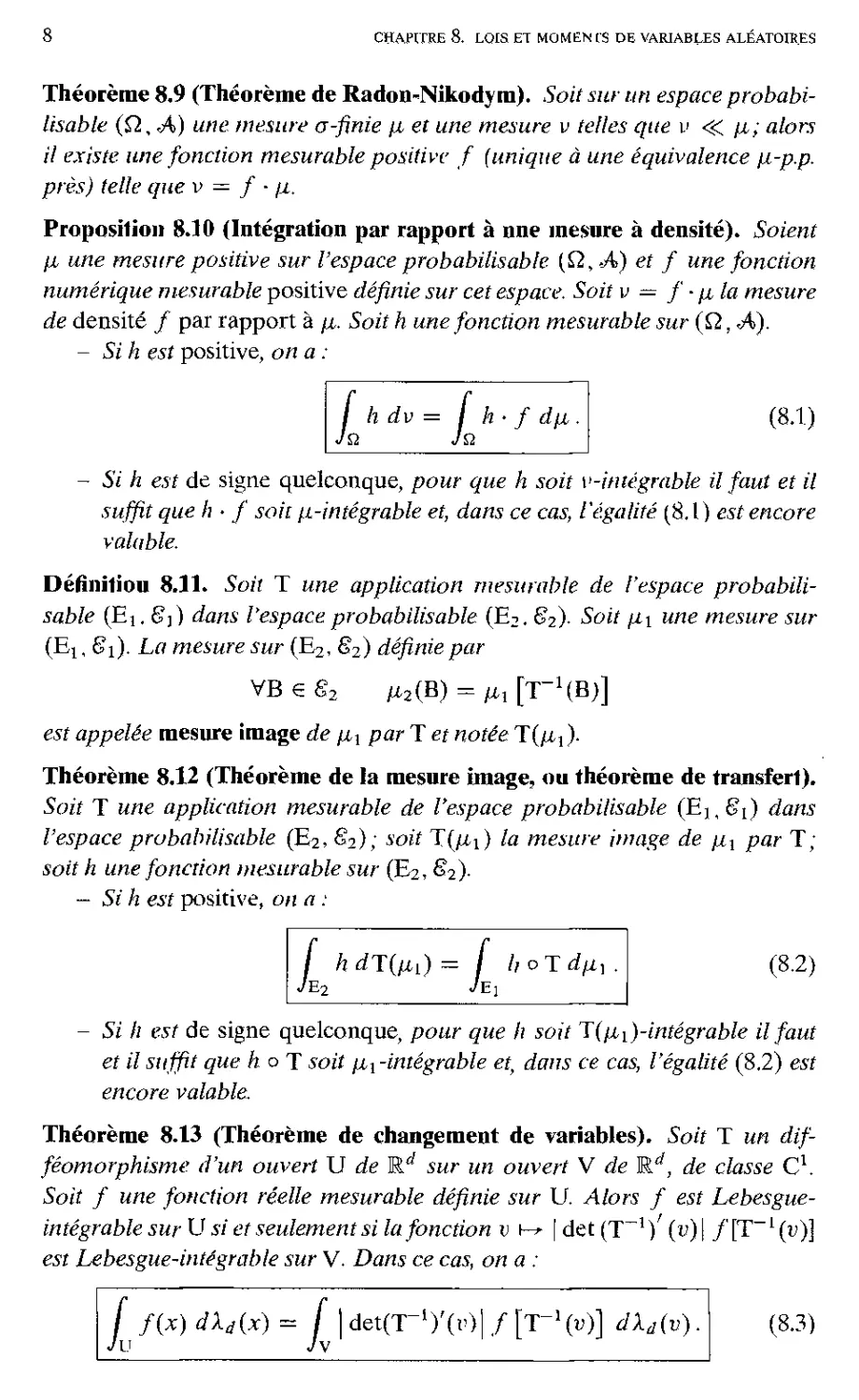

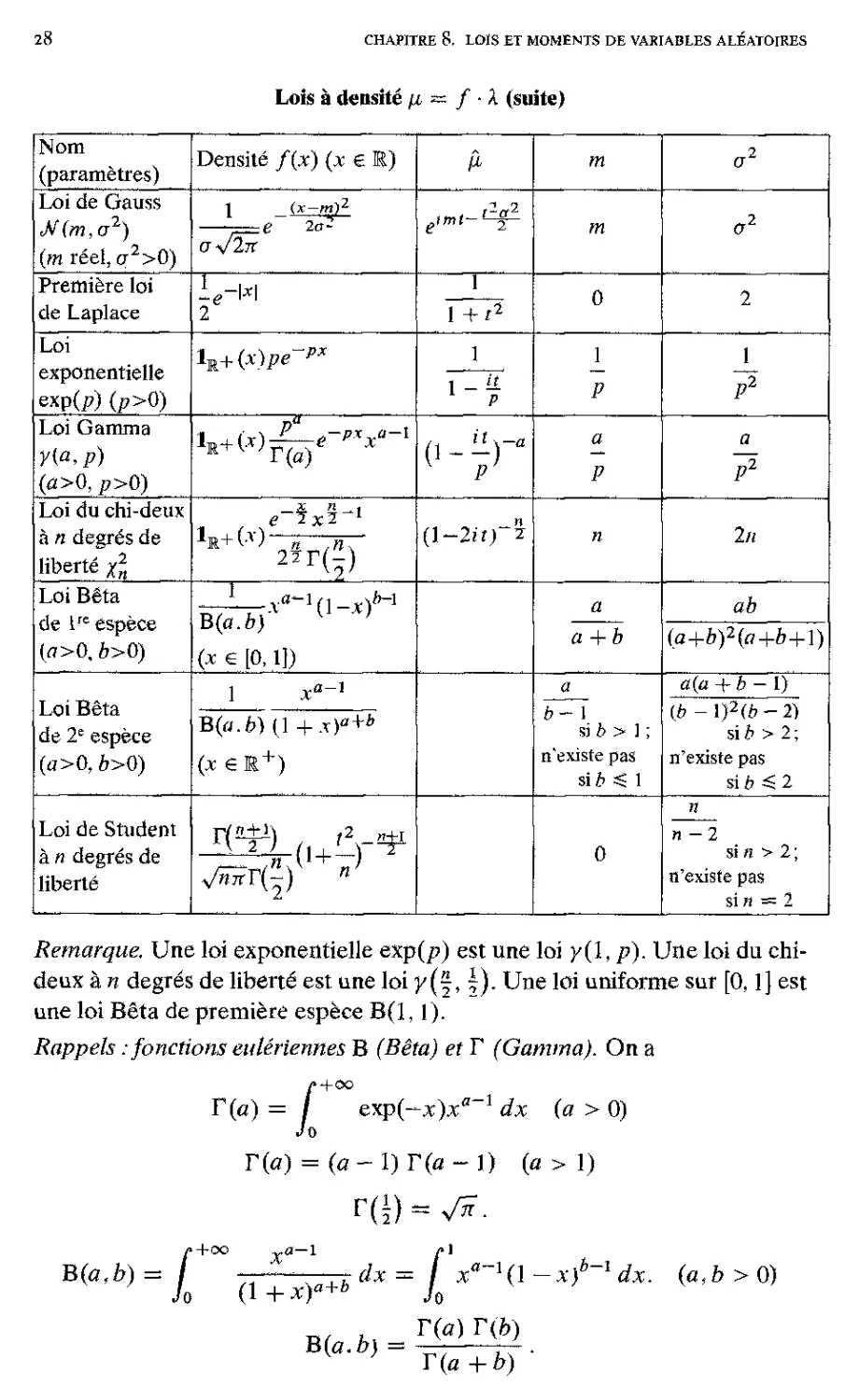

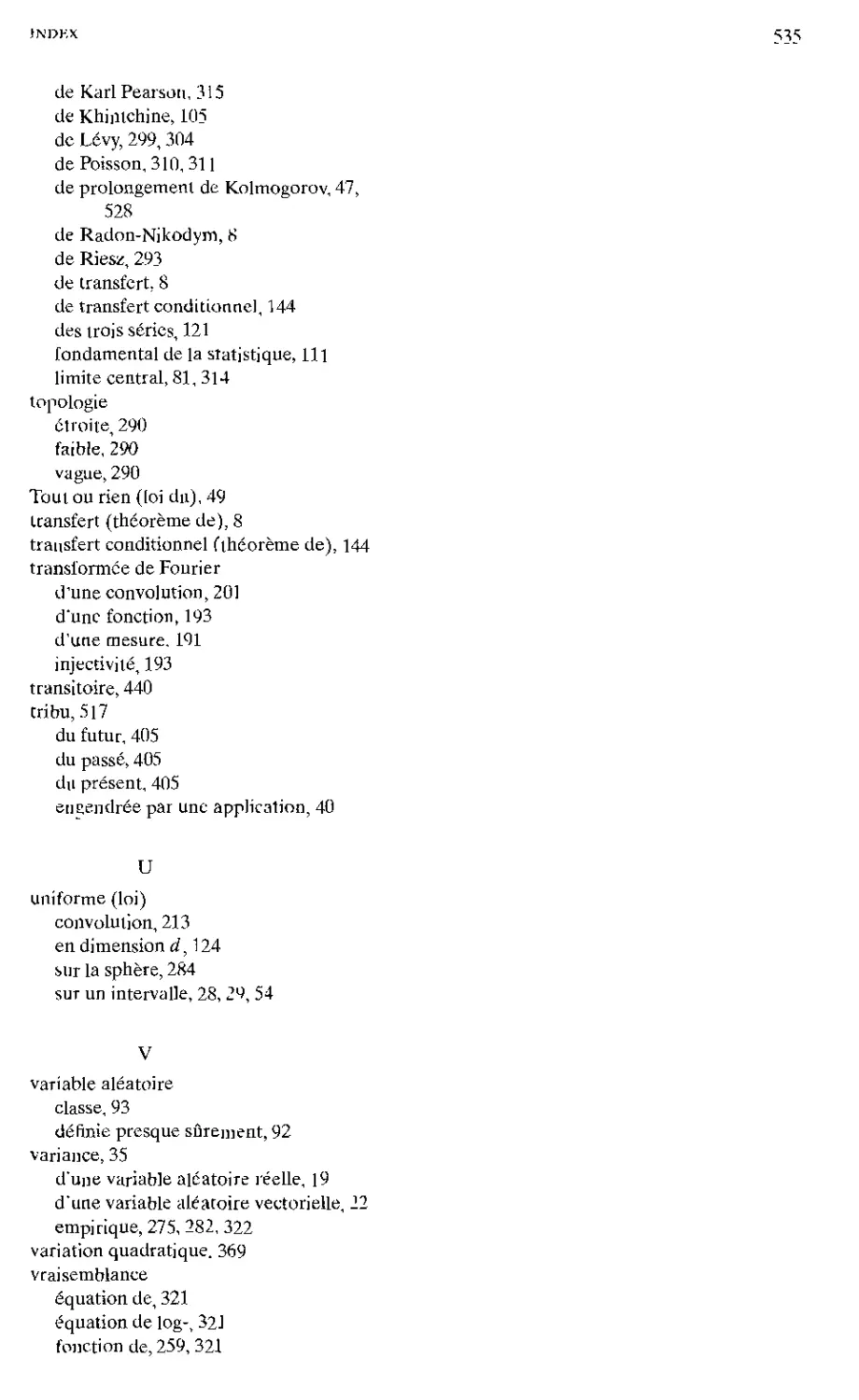

28

chapitre 8. lois et moments de variables aléatoires

Nom

(paramètres)

Densité f(x) (x e

¡1

Loi de Gauss

(m réel, cr2>0)

1

u-Jïk

(x—mi2

e 2d-

V

Première loi

de Laplace

1 +r

Loi

exponentielle

exp(f>) (j?>0)

lR+(x)pe

l~7

Loi Gamma

Y{a,p)

(a>0, p>0)

x\JL-e-pxxa-i

0-rP

Loi du chi-deux

à n degrés de

liberté xl

"jc2"

2«

Loi Bêta

de lre espèce

(fl>0, ö>0)

T

B(o.ö)

(* e [o, U)

b-\

ab

a+b

(a+b)2(a+b+i)\

Loi Bêta

de 2e espèce

(a>0, b>0)

1

ä(ä + b - I)

B(r;.è) (1 + x)a+b

(x e R+)

b- 1

si & > ] ;

n'existe pas

si£ ^ 1

{b - l)2(b-2)

üb > 2;

n'existe pas

sib 5 2

Loi de Student

à n degrés de

liberté

r(ïp-) t2 ü±i

n-2

si « > 2 ;

n'existe pas

sin = 2

Remarque. Une loi exponentielle exp(p) est une loi y{\, p). Une loi du chi-

deux à n degrés de liberté est une loi y(~, 5). Une loi uniforme sur [0,1] est

une loi Bêta de première espèce B(l, 1).

Rappels .-fonctions eulériennes B (Bêta) et T (Gamma). On a

/• + 00

I» = / &xp(~x)xa~l dx (a > 0)

T(a) = (a - 1) T(a - 1) (a > 1)

B(a,b)= i dx = I xa~l(\-xf-ldx. (a,b>0)

(1 + x)a Jq

B{a.b) =

= f xa~H\-x)b-ldx. (a,b

h

T(a) T(b)

T(a+b) "

Lois à densité fi = / ¦ X (suite)

exercice 8.1

29

exercices

Toutes les variables aléatoires introduites sont définies sur un même

espace probabilisé (Q, A, P).

Exercice 8.1. Résultat fondamental pour In simulation de lois de probabilité. Soit

X une variable aléatoire de fonction de répartition F. On définit la fonction G de la

variable réelle par

Vf g R G(f) = inf(x I F(x) > f) ;

cette fonction G est appelée pseudo-inverse de F.

1. Démontrer successivement que

(a) si F est continue, on a, pour tout t e]0,1 [, F[G(f )] = f ;

(b) si F est strictement croissante, on a, pour tout x g R, G\F(x)] = x ;

(c) si F est continue et strictement croissante, F est bijective de R sur ]0,1 [ et on a

G = F-1.

2. Démontrer que si F est continue et strictement croissante, F(X) suit la loi

uniforme sur {0,1].

3. Démontrer que si Y suit la loi uniforme sur [0,1], la variable aléatoire G (Y)

admet F comme fonction de répartition.

Solution.

1. On sépare bien l'influence des hypothèses de monotonie et de continuité.

(a) Soit, pour tout t g]0,1{, l'ensemble A( ~ {x \ F(x) S t). C'est une demi-

droite car, F étant croissante, pour tout xq g A( et tout y ^ xo, on a

F (y) =: F(*o) S t, et donc, y e A(. De plus, on a

F{G(f)]^f7

en effet, puisque G(t) = inf A, et que Ar est une demi-droite, pour tout

y > G(f), on a y € At et donc F (y) ^ t. La fonction F étant continue à droite,

il suffit de prendre une suite de réels yn € Ar convergeant en décroissant vers

G(f), pour obtenir :

F[G(f)]=lim\F(y„)£f.

Si F est continue, on a de plus :

F[G(Q]gf7

en effet, par définition de G, pour tout y < G(f), on a F (y) < t. La fonction

F étant continue à gauche, il suffit de prendre une suite de réels y„ < G(f)

convergeant en croissant vers G(f), pour obtenir :

F[G(f)]=lim/F(y„)^f.

Au total, si F est continue, on a, pour tout t e]0, l{,F{G(f)] = t.

30

chapitre 8. lois et moments de variables aléatoires

(b) Pour tout x e R, par définition de G, on a

G [F(x)] = inf(y | F(y) S F(x)) $ x ;

de plus, si F est strictement croissante, pour tout y tel que F(y) S F(x), on a

y £ x (sinon, on aurait y < v, et donc F(y) < F(x)), ce qui démontre que

G|F(x)] > x. Il en résulte que G[F(x)] = x.

(c) Si F est continue et strictement croissante, on a à la fois :

Vt e ]0,1[ F[G(f)] =t et Vx e R G\F(x)] = x.

Il en résulte que F est bijective de R sur ]0,1 [ et que : G = F-1.

2. Si F est continue, pour tout y e]0, 1[, on a F[G(y)] = y et donc, en utilisant la

croissance stricte de F,

P[F(X) S y] = P[F(X) S F[G(y)]] = P[X ^ G(y)] = F [G(y)] = y .

Puisque de plus on a

P[F(X)^y] =

0 si y < 0

1 si y > 1 ,

F(X) suit la loi uniforme sur [0,1].

3. On a l'équivalence : F(x) >. t x S G(f) ; donc, si Y suit la loi uniforme sur

[0, l],ona:

Vx eR P [G(Y) ^ x] = P [Y ^ F(x)] = F(x),

ce qui démontre que G(Y) admet F comme fonction de répartition.

Remarque. Les résultats de cet exercice permettent théoriquement de simuler toute

loi sur E à partir d'une variable aléatoire de loi uniforme. En effet, un appel à la

fonction « random >• (ou « rand >' ou autre appellation, suivant les langages) d'un

ordinateur est censé donner une réalisation y d'une variable aléatoire Y de loi

uniforme sur [0,1], ce nombre •.< aléatoire », ou au hasard, étant fabriqué par un

générateur uniforme. Si on veut simuler une variable aléatoire réelle de fonction

de répartition F, on calcule (lorsque c'est faisable) sa pseudo-inverse G. et G(y)

est alors une réalisation de la variable aléatoire G(Y) de fonction de répartition F.

Cette méthode peut être numériquement très lourde, ou même impraticable ; des

méthodes spécifiques existent pour simuler un certain nombre de lois classiques,

comme on le met en évidence dans les exercices suivants.

Exercice 8.2. Simulation de lois de variables aléatoires discrètes. Soit X une

variable aléatoire réelle discrète prenant les valeurs d'une suite strictement

croissante (x„)„eN telle que, pour tout « e H, P(X = x„) = pn > 0, avec £^=o pn = l.

Soit U une variable aléatoire de loi uniforme sur [0. 1], et Y la variable aléatoire

définie par

Y = Xo l(U<p0) + 1(?+P)+'"+P/7-l<U</>o+/>l+"'+/>>,)¦

exercice H-4

31

Vérifier que X et Y ont même loi.

Solution. On a

P(Y = .t0) = P(U</7„) = /;û

et. pour n ? 1,

P(Y = xn) = Hpo + pi +¦¦¦ + p„-i < U < pn + px H h pn) = p„ .

Remarque. Le résultat de cet exercice permet donc de simuler toute loi discrète sut

M à partir d'une variable aléatoire de loi uniforme.

Exercice 8.3. Simulation de la loi exponentielle. Soit U une variable aléatoire de loi

uniforme sur [0,1], et X la variable aléatoire définie par X = —j ln(U), où p > 0.

Déterminer la loi de X.

Solution. En appliquant le théorème de transfert, puis en effectuant le changement

de variable associé au difféomorphisme de ]0, l[ sur JK+* défini par v = ~ ln(u), il

ce qui démontre que Px est la loi exp(p). Remarque. Le résultat de cet exercice

est couramment utilisé pour simuler une loi exponentielle à partir d'une variable

aléatoire de loi uniforme, sans avoir recours à la méthode générale (mais plus lourde)

d'inversion de la fonction de répartition.

Exercice 8.4. Lois normales dans Rz, lois exponentielle et de Hotelling. Soit

X = (Xi.Xi) une variable aléatoire à valeurs dans R2 de loi normale -^2(0.1),

c'est à dire admettant une densité /x donnée par

où )) ¦ )1 désigne la norme euclidienne usuelle.

L Déterminer la loi de la variable aléatoire ||X||-.

2. Soit D = {(^1,^2) € M2 | xi = X2}. Démontrer que la variable aléatoire T

définie par

admet une densité ; la calculer (la loi de T est appelée loi de Hotelling ).

7. Cette loi apparaît dans l'étude du test de comparaison d'une moyenne expérimentale à

une moyenne théorique (cf., par exemple, C. Fourgeaud et A. Fuchs, Statistique, Dunod, p. 129)

vient :

32

chapitre 8. lois et moments de variables aléatoires

Solution.

1. Par application des théorèmes de transfert et d'intégration par rapport à une

mesure à densité, on a, pour tout / € rJ^(M),

E/(||X||2) = j f^xf)±atp(-^f.)dk2(x)

= f, f{\\x\\2)^sxp(~^p)dk2(x).

Jr2\1+x{o} 2tt v 2 /

Effectuons le changement de variables en coordonnées polaires associé au difféo-

morphisme de K+*x]0, 2tt[ sur R2 \ E+ x {0} défini par

x = p cos 9 y = p sin 9 ,

de jacobien p, et appliquons le théorème de Fubini :

E/(||X||2) = f f{p2)±eXp(^\pd{X®X)(p,e)

= f f(p2)exP(-Ç)pd\(p).

Par un dernier changement de variables associé au difféomorphisme de R+* sur

lui-même défini par u = p2, on obtient :

V/e^(R) E/(||X||2) = f /(k)ix+(„)Iexp(-^) d\(u),

ce qui démontre que ||X||2 a la loi exponentielle exp(i).

2. Par application des théorèmes de transfert et d'intégration par rapport à une

mesure à densité, on a pour tout / e l?^(R) (puisque X2(D) = 0) :

jr2\D LVxj -x2/ -I2jt V 2 /

Effectuons le changement de variables associé au difféomorphisme de R2 \ D sur

R2 \ ({0} x R) défini par

X[ + x2

u

Xi - x2

V — X\ 4- x2

Xl = ~(v + -I

2V u'

1 , V.

2V u'

de jacobien

D(X|'^=detf^ Ì(1 + ^|-_JL

V 2u2 2U u'

exercice 8-5

33

et appliquons le théorème de Fubíní ; on obtient, pour tout / € (?),

E/(T) =i- Í /(w2)exp[-ii;2(l + ^)]|^|aA®A(U,i;)

4tt Jm* m Lys rL 4 w2'J J

Mais, par comparaison des intégrales de Lebesgue et Riemann généralisées, on a

jf |„| exP[--U2<l + ¿)] dX(v) = 2Jo+OC v exp[-I,2{l + ¿)] dv

, + oc g

= / —pexp(—ui) au)

y° 1 + ^

1 '

1 + -r

u2

d'où, pour tout / e

E/(T)=i /* /[M2]_2 =_1 /* t ff)/(f) 1 dX(t).

n Jr* w- + 1 jt A (r + l) s/;

Ceci démontre que T admet la densité fy donnée par

c'est une loi Bêta de deuxième espèce : B{^,

Exercice 8.5. Moments d'ordre a et théorème de Fubini. Soient X une variable

aléatoire positive et G la fonction définie par

Vx € R G(x) = P(X > x).

Démontrer que pour que X admette un moment d'ordre a ^ 1, il faut et il suffit

que la fonction x h> xa_ 1 G(xï soit Lebesgue-integrable sur R+ et que, dans ce cas,

on a :

E(Xa) = a f x°~lG(x)dX(x).

Jr+

Solution. D'après le théorème de Fubini pour les fonctions mesurables positives, on a

f xa'1G(x)dX(x) - f x""' f l(x>x)dP dX(x)

J&+ Jr+ Un

= (\ f x^l^dXix)

Jq et

dP

34

chap! ire 8. lois et' moments de variables aleatoires

d'où le résultat.

Exercice 8.6. Formulation équivalente de l'inégalité de Hôlder. Soient p, q et r des

réels positifs tels que 4- ~ = ~ ; démontrer que

1. Pour toutes variables aléatoires X, Y à valeurs dans R+ et définies P-p.s., on a

l'inégalité dans M :

(j (XY)VP)17'' 5 XpdPy/P(j Y*dpy/<1. (8.15J

2. Si X € XP{Q.A,P) et Y € &(Q,A.V), on a XY € X\Q.A,P) et on a

l'inégalité

||XY||, í ||X||_ ||Y|L . (8.16J

En déduire que si p, q et r sont des réels positifs tels que ~ + | + £ = 1, si

X e XP(Q,A. P), Y e £«(£2, AP) et Z e ^(Œ.^.P), alors XYZ e X'(f2,^,P)

et on a l'inégalité :

IIXYZII,^ ||X|L IIYIL ||Z||r . (8.17)

Solution.

1. Il résulte de l'inégalité (8.6) appliquée aux variables aléatoires Xr et Yr avec les

réels conjugués j et f que l'on a

/

?Pí(í (x')*/r ^)r/"(í (Yr)¿p)r/*,

ce qui, en élevant à la puissance ~. donne l'inégalité (8.15).

2. SiX € XP(Q, A, P) et Y e £«(£2, A P), il en résulte que

/n?P,(/n|x^r,<(/n|Y^Py

< +0O ,

et donc que XY e dC(f2,^,P); l'inégalité (8.16) en résulte.

Remarque. Cette formulation est donc équivalente à celle donnant l'inégalité de

Hôlder (pour la réciproque, prendre r = 1).

Enfin, si p, q et r sont des réels positifs tels que ~ + ^ + £ = 1. définissons a par la

relation ì = A + ±. Soient X e d£p(í2, A, P), Y € d£?(£2, A, P) et Z e Xr(Q.A,P);

d'après ce qui précède, on a YZ e Xa(Q. A,~P) et

||YZ||a Í ||Y||? ||Z||r .

Les réels a et p étant conjugués, le produit X(YZ) est integrable, l'inégalité de

Hôlder donne

IIXÍYZ)!!, Í ||X||p ||YZ||B ,

ce qui, en vertu de l'inégalité précédente démontre l'inégalité (8.17).

liXERCICE S.S

35

Exercice 8.7. Variance, opérateur de covariance et support de loi. Soit X e

X2,(Q,A,'P) une variable aléatoire à valeur dans un espace euclidien F, d'opérateur

de covariance Ax- Démontrer d'abord que si F = K, on a :

X = EX P-p.s. <=^> ox = 0.

En déduire que dans le cas général, on a :

P-p.s. (X - EX) e (ker AX)X .

Solution. Si F = K, on a :

a2. = 0 E(X - EX)2 = 0 <=> X = EX P-p.s.

Dans le cas général, on a alors :

x 6 kerAx E({X.x)2) = 0 (x.x) =0 P-p.s.

Soit alors (ei)i=ii__.j une base de kerAx- Pour tout i = 1,...,/, il existe un

o

ensemble de probabilité nulle Ni tel que, pour tout tu ^ N/, on ait : (X(ft)),ej) = 0.

Soit N = (J=1 H ; on a P(N) = 0 et

V« ^ N V/ = 1,...,/ {X(ûj),«i) = 0,

et donc : _^__^^__„

Vw £ N X(w) G (kerAx)"1" ¦

Exercice 8.8. Généralisation du problème de régression linéaire au cas de variables

aléatoires à valeurs dans un espace euclidien. Soient deux variables aléatoires

X 6 X2(?2, AP) et Y e Z^iQ.A,?) où F et G sont des espaces euclidiens;

on suppose que l'opérateur d'auto-covariance Ax est inversible. On cherche une

« meilleure » approximation de Y comme fonction affine de X au sens des moindres

carrés, à savoir une solution en le couple (A,b) e £(F, G) x G du problème de

minimisation :

inf($(A, b) | (A, b) e X (F. G) x G),

où :

4>(A,fc) =E||Y-(AX+£)||2 .

On introduira l'opérateur d'interrovariance de X et Y, unique opérateur Ax,y £

£(F, G) vérifiant :

V(x, y) e F x G (Ax,y*, .v) = E[(X, x)(Y. y)],

et on remarquera que : Ax y = (Ay,x)*-

36 CHAPITRE 8. LOIS ET MOMENTS DE VARIABLES ALÉATOIRES

o o

Solution. On a. Y — AX étant centrée :

$(A,b) =E||Y-AX+(EY-AEX-ô)||2

= E||Y-AX||2+ ||EY-AEX-è||2 +2E{Y-AX, EY-AEX-è)

= E||Y-AX||2 + ||EY-AEX-6||2

Pour tout A fixé, cette quantité est minimum pour 6a = EY - AEX. Reste à

minimiser en A :

$(A,ÎA) = E||Y-AX||2.

Mais on a :

E||Y-AX||2 =trE[(Y-AX)(Y-AX)*]

roo* oo* o o * o °

= trE[YY + A(XX )A* - (Y X )A* - AXY*]

= tr [Ay + AAXA* - Ax,yA* - AAY,x] ¦

Si * est l'application (différentiable) de Z(F, G) dans M définie par

*(A) = tr[AY + AAXA* - Ax,yA* -AAy,x] ,

son application dérivée est donnée par

VH € Z(F, G) tf'(A)(H) =tr[HAxA*+AAxH*-AXYH*-HAY,X]

= 2tr[(AAx-Ax,Y)H*] .

Un point stationnaire A est donné par

a= Ax.yAx1 -

Ce point stationnaire correspond bien à un minimum. En effet, on a :

VH g Z(F, G) tf"(A)(H)(H) = 2tr [HAXH*] S 0.

De plus, si (^r)i=i,„. d est une base orthonormée de G, on a

d d d

tr[HAxH*]«E(HAxH^,eI-)=E(AxH*ei,H*«i)«E|AxÏH*«.-| !

/=1 7=1 j=l

puisque Ax est inversible, il en résulte que *"(A)(H)(H) = 0 si et seulement si

H*e,- = 0 pour tout i = 1 d, autrement dit. si et seulement si H*, donc H, est

nul. Cela assure que A correspond à un minimum.

La solution du problème de régression linéaire est le couple

(A,î-) = (Ax.yAxVEY-AjcyA^CEX)).

La surface D (sous-espace affine) d'équation

0,_ey)-ax.yAx-1(.*-ex) = o]

exercice S.fi

37

est appelée surface de régression linéaire de Y en X. La ¦< meilleure » approximation

de Y comme fonction affine de X au sens des moindres canes est

EY + Ax,yAx1(X-BX)

et on a P [(X, Y) € D] = 1 si et seulement si $(Â,= 0.

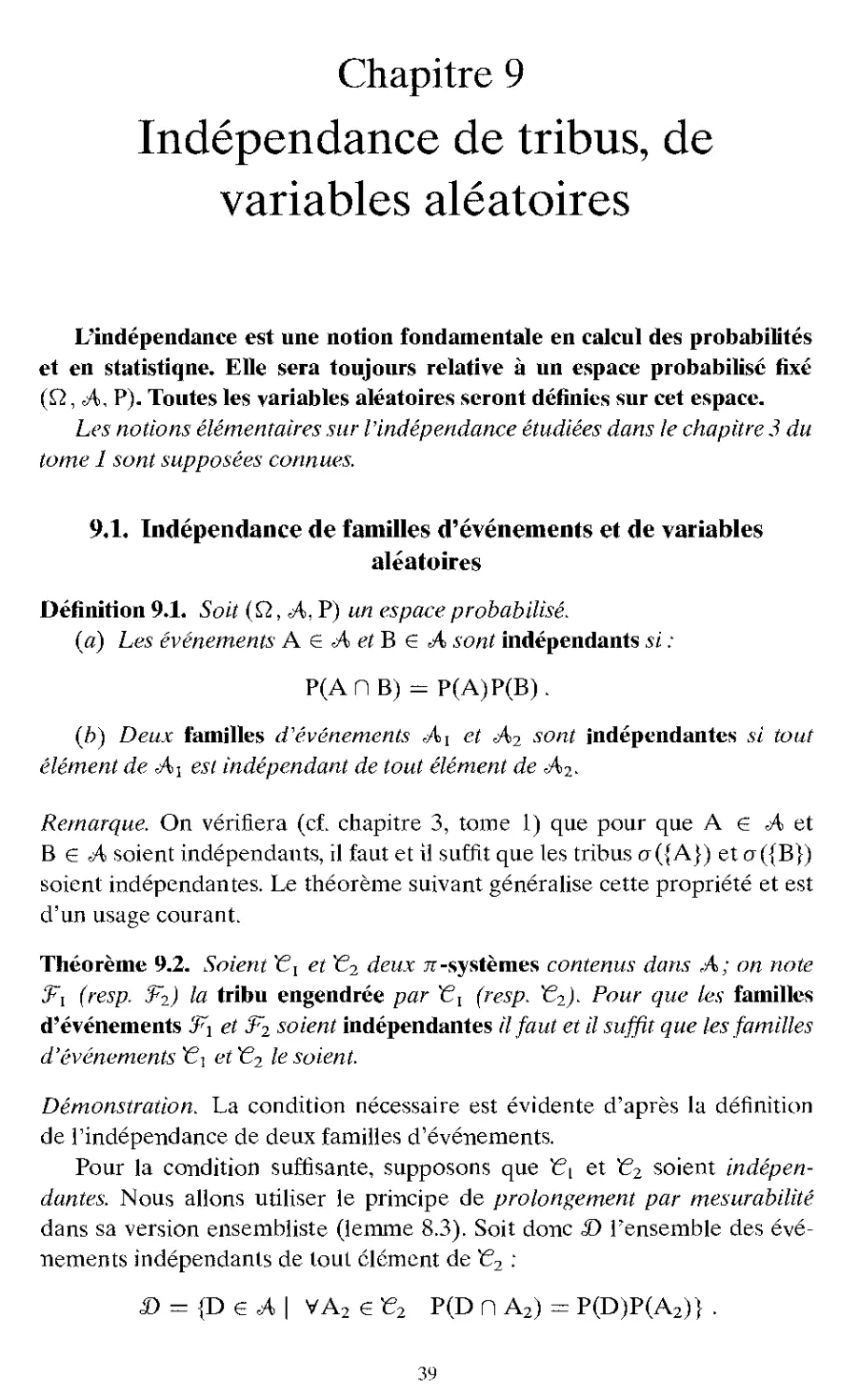

Chapitre 9

Indépendance de tribus, de

variables aléatoires

L'indépendance est une notion fondamentale en calcul des probabilités

et en statistique. Elle sera toujours relative à un espace probabilisc fixé

(Q, A. P). Toutes les variables aléatoires seront définies sur cet espace.

Les notions élémentaires sur l'indépendance étudiées dans le chapitre 3 du

tome 1 sont supposées connues.

9.1. Indépendance de familles d'événements et de variables

aléatoires

Définition 9.1. Soit (Q, A., P) un espace probabilisé.

(a) Les événem.ents A e A et B G A sont indépendants si :

P(AH B) = P(A)P(B).

(b) Deux familles d'événements Ai et A2 sont indépendantes si tout

élément de Ai est indépendant de tout élément de A2.

Remarque. On vérifiera (cf. chapitre 3, tome 1) que pour que A e A et

B € A soient indépendants, il faut et il suffit que les tribus a ({A}) et a ({B})

soient indépendantes. Le théorème suivant généralise cette propriété et est

d'un usage courant.

Théorème 9.2. Soient Gl et G2 deux n-systèmes contenus dans A; on note

J^i (resp. 3*2) la tribu engendrée par t?, (resp. KC2). Pour que les familles

d'événements 'â~i et soient indépendantes il faut et il suffit que les familles

d'événements t?i et G2 le soient.

Démonstration. La condition nécessaire est évidente d'après la définition

de l'indépendance de deux familles d'événements.

Pour la condition suffisante, supposons que t?L et ~G2 soient

indépendantes. Nous allons utiliser le principe de prolongement par mesurabilité

dans sa version ensembliste (lemme 8.3). Soit donc D l'ensemble des

événements indépendants de tout clément de ~€2 :

D = {D g A | VA2gE2 P(D n A2) = P(D)P(A2)} .

39

chapitre 9, indépendance de tribus, de variables aléatoires

Par hypothèse, t?, c <£> et 0, e £>. Démontrons que £> est un À-système.

- Si D] et D2 e £> sont tels que Di D D2, on a, pour tout A2 e f2.

Comme de plus {Jn&N D„ e A, il vient : [JneN D« e 10 •

Il résulte alors du principe de prolongement par mesurabilité que D D

.Fi, ce qui s'écrit :

VF, e F, VA2 e ç2 P(F, n A2) = P(F0P(A2). (9.1)

Soit alors S l'ensemble des événements indépendants de tout élément de

Fi ¦

S = {E e A I VF, e f, P(Fi nE) = PfFOPfE)} .

La relation (9.1) s'écrit S D t2. On a Q e g et g est bien sûr encore

un À-système ; il résulte alors encore du priucipe de prolongement par

mesurabilité que S D 3*2, ce qui démontre le théorème. ?

Notation et rappel. Soit X une application de Q dans E ; si § est une famille

de parties de E, on note X-1 (§) la famille de parties de Q ;

En particulier, si § est une tribu sur E, la famille X 1 (§) est une tribu sur Q

dite tribu engendrée par l'application X.

Définition 9.3. Soient X,-, i — 1,2, deux variables aléatoires définies sur

l'espace probabilisé (p,,A,Y) à valeurs dans des espaces probabilisables

respectifs (Ei; Si). Les variables aléatoires X, et X2 sont indépendantes si

les tribus X.Jl(8\) et X2 1 (82) engendrées respectivement par les applications

Xi et X2 sont indépendantes.

VneN VA2 e £2 P(D„ n A2) = P(D„)P(A2).

et donc, par limite monotone,

{X-1(G) e I G &¦§} .

ç). i. indépendance de familles d'événements et de variables aléatoires

41

Remarque d'usage courant. Soient, pour i = 1,2, deux variables aléatoires

X, définies sur l'espace probabilisé (Q,fA,P) à valeurs dans des espaces

probabilisables respectifs (Ef. £,) et f deux applications mesurables de

(E,, 8j) dans l'espace probabilisable (Fj, 3^). Si les variables aléatoires X*

sont indépendantes, il en est de même des variables aléatoires f o X;

(souvent notées f(Xi)).

Exemple. Si les variables aléatoires X, sont à valeurs dans Udi et sont

indépendantes, toute marginale de X[ est indépendante de toute marginale

de X2.

Proposition 9.4. Avec les notations précédentes, soit, pour i = 1,2, un n-

système t?, engendrant Pour que les variables aléatoires X, et X2 soient