Теги: исследование операций математика программирование базы данных моделирование аналитика

ISBN: 978-5-4461-1039-1

Год: 2019

Текст

С&ППТЕР'

Applied

Predictive Modeling

Max Kuhn and Kjell Johnson

Springer

Препиктивное моделирование на практике

Макс Кун и Кьвлл Джонсон

С^ППТЕР’

Санкт-Петербург • Москва * Екатеринбург•Воронеж Нижний Новгород•Ростов-на-Дону

Самара > Минск

2019

ББК 22.183.5

УДК 519.8

К91

Кун Макс, Джонсон Кьелл

К91 Предиктивное моделирование на практике. — СПб.: Питер, 2019. — 640 с.: ил. — (Серия «Для профессионалов»).

ISBN 978-5-4461-1039-1

«Предиктивное моделирование на практике» охватывает все аспекты прогнозирования, начиная с ключевых этапов предварительной обработки данных, разбиения данных и основных принципов настройки модели. Все этапы моделирования рассматриваются на практических примерах из реальной жизни, в каждой главе дается подробный код на языке R.

Эта книга может использоваться как введение в предиктивные модели и руководство по их применению. Читатели, не обладающие математической подготовкой, оценят интуитивно понятные объяснения конкретных методов, а внимание, уделяемое решению актуальных задач с реальными данными, поможет специалистам, желающим повысить свою квалификацию.

Авторы постарались избежать сложных формул, для усвоения основного материала достаточно понимания основных статистических концепций, таких как корреляция и линейный регрессионный анализ, но для изучения углубленных тем понадобится математическая подготовка.

Для работы с книгой нужно иметь базовые знания о языке R. Премия Zecgel Technometrics 2014.

16+ (В соответствии с Федеральным законом от 29 декабря 2010 г. № 436-ФЗ.)

ББК 22.183.5

УДК 519.8

Права на издание получены по соглашению с Springer Science+Business Media, LLC. Все права защищены. Никакая часть данной книги не может быть воспроизведена в какой бы то ни было форме без письменного разрешения владельцев авторских прав.

Информация, содержащаяся в данной книге, получена из источников, рассматриваемых издательством как надежные. Тем не менее, имея в виду возможные человеческие или технические ошибки, издательство не может гарантировать абсолютную точность и полноту приводимых сведений и не несет ответственности за возможные ошибки, связанные с использованием книги. Издательство не несет ответственности за доступность материалов, ссылки на которые вы можете найти в этой книге. На момент подготовки книги к изданию все ссылки на интернет- ресурсы были действующими.

ISBN 978-1461468486 англ.

First published in English under the title Applied Predictive Modeling, 1st Edition by Max Kuhn, Kjell Johnson by Springer Science+Business Media, LLC © 2013, Springer Science+Business Media New York

This edition has been translated and published under licence from Springer Science+Business Media, LLC.

Springer Science+Business Media, LLC takes no responsibility and shall not be made liable for the accuracy of the translation.

ISBN 978-5-4461-1039-1

© Перевод на русский язык ООО Издательство «Питер», 2019

© Издание на русском языке, оформление ООО Издательство «Питер», 2019 ©Серия «Для профессионалов», 2019

Краткое содержание

Предисловие 18

Глава 1. Введение 21

ЧАСТЫ

ОБЩИЕ СТРАТЕГИИ

Глава 2. Краткий обзор процесса предиктивного моделирования 42

Глава 3. Предварительная обработка данных 51

Глава 4. Переобучение и настройка модели 87

ЧАСТЬ II РЕГРЕССИОННЫЕ МОДЕЛИ

Глава 5. Измерение эффективности регрессионных моделей 122

Глава 6. Модели с признаками линейной регрессии 128

Глава 7. Нелинейные регрессионные модели 169

Глава 8. Древовидные модели. Модели на базе правил 202

Глава 9. Обзор моделей растворимости 254

Глава 10. Практический пример: сопротивление сжатию бетонных смесей 257

6 Краткое содержание

ЧАСТЬ III

КЛАССИФИКАЦИОННЫЕ МОДЕЛИ

Глава 11. Определение эффективности в классификационных моделях 278

Глава 12. Дискриминантный анализ и другие линейные классификационные

модели 307

Глава 13. Нелинейные классификационные модели 365

Глава 14. Деревья классификации и модели на базе правил 407

Глава 15. Сравнительный анализ моделей для заявок на получение грантов 456

Глава 16. Решение проблемы дисбаланса классов 460

Глава 17. Практикум: планирование заданий 488

ЧАСТЫУ ПРОЧИЕ ВОПРОСЫ ПРЕДИКТИВНОГО МОДЕЛИРОВАНИЯ

Глава 18. Определение важности предикторов 506

Глава 19. Выбор признаков 531

Глава 20. Факторы, влияющие на эффективность модели 567

ПРИЛОЖЕНИЯ

Приложение А. Краткая сводка различных моделей 596

Приложение Б. Введение в R 599

Приложение В. Рекомендуемые веб-сайты 616

Список источников 619

Оглавление

Предисловие 18

От издательства 20

Глава 1. Введение 21

1.1. Прогнозирование и интерпретация 24

1.2. Ключевые ингредиенты предиктивных моделей 25

1.3. Терминология 27

1.4. Примеры наборов данных и типичные сценарии данных 29

Музыкальный жанр 29

Заявки на получение грантов 30

Поражение печени 31

Проницаемость 32

Производство химикатов 32

Мошенничество в финансовых отчетах 33

Сравнения наборов данных 34

1.5. Структура книги 36

1.6. Условные обозначения 38

ЧАСТЬ I

ОБЩИЕ СТРАТЕГИИ

Глава 2. Краткий обзор процесса предиктивного моделирования 42

2.1. Пример прогнозирования экономии топлива 42

2.2. Аспекты, заслуживающие отдельного рассмотрения 48

Разделение данных 48

Данные предикторов 48

Оценка эффективности 49

Оценка нескольких моделей 49

Выбор модели 49

2.3. Итоги 50

Глава 3. Предварительная обработка данных 51

3.1. Практический пример: сегментация клеток в высокопроизводительном

скрининге 53

3.2. Преобразования данных для отдельных предикторов 55

Центрирование и масштабирование 55

Преобразования для устранения смещения 55

3.3. Преобразования данных с несколькими предикторами 58

Преобразования для решения проблемы выбросов 58

Прореживание данных и выделение признаков 60

3.4. Отсутствующие значения 66

3.5. Удаление предикторов 69

Корреляции между предикторами 71

3.6. Добавление предикторов 73

3.7. Группировка предикторов 75

3.8. Вычисления 77

Преобразования 79

Фильтрация 81

Создание фиктивных переменных 83

Упражнения 85

Глава 4- Переобучение и настройка модели 87

4.1. Проблема переобучения 88

4.2. Настройка модели 90

4.3. Разделение данных 93

4.4. Методы повторной выборки 96

К-кратная перекрестная проверка 96

Обобщенная перекрестная проверка 98

Повторное разделение тренировочного/тестового набора 98

Бутстрэп 99

4.5. Практикум: оценка кредитоспособности 101

4.6. Выбор итоговых параметров настройки 101

4.7. Рекомендации по разделению данных 105

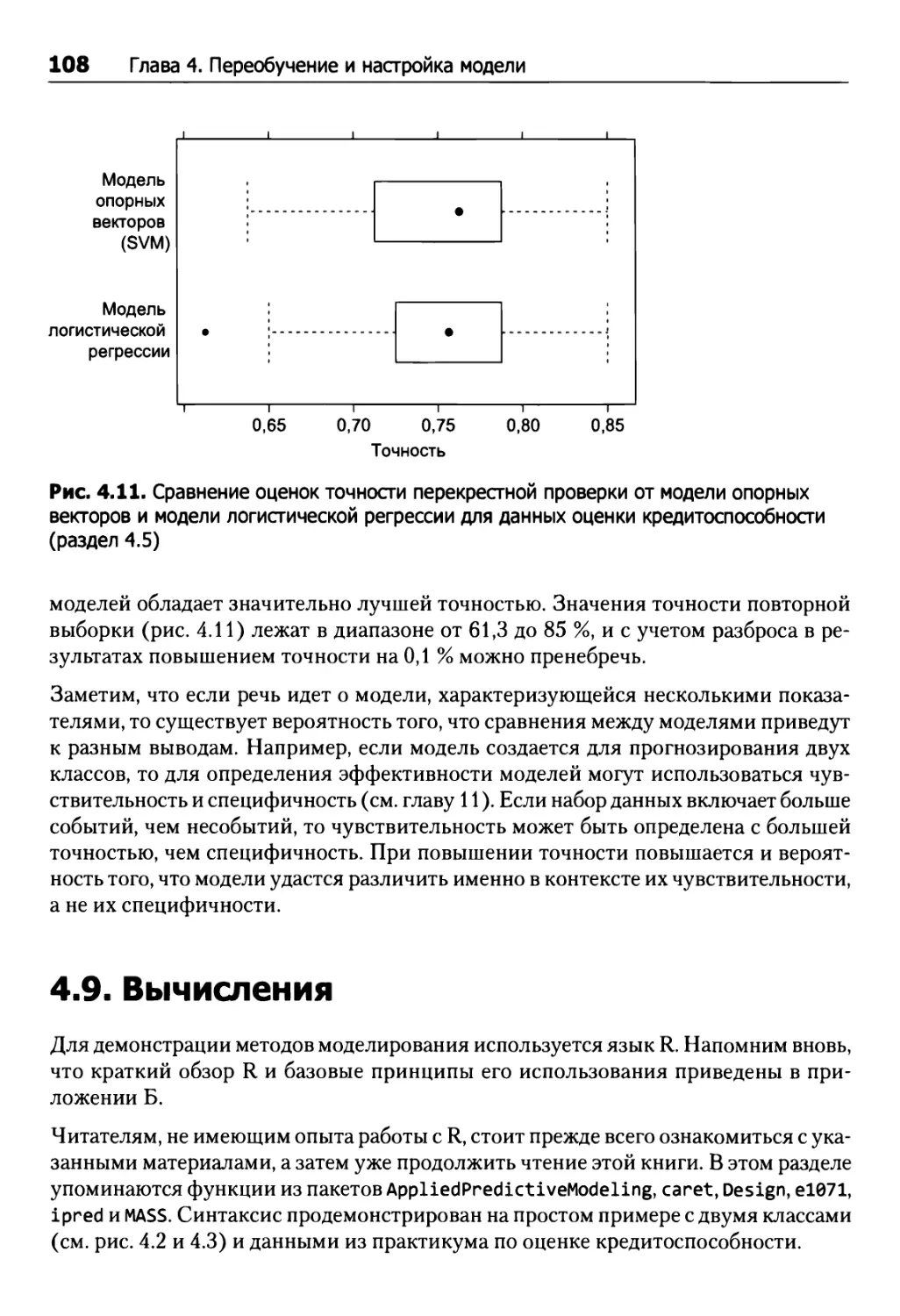

4.8. Выбор между моделями 106

4.9. Вычисления 108

Разделение данных 109

Повторная выборка 110

Базовый процесс построения модели в R 111

Определение параметров настройки 112

Сравнение моделей 116

Упражнения 118

ЧАСТЬ II

РЕГРЕССИОННЫЕ МОДЕЛИ

Глава 5. Измерение эффективности регрессионных моделей 122

5.1. Количественные показатели эффективности 122

5.2. Обратное отношение между смещением и дисперсией 124

5.3. Вычисления 126

Глава 6. Модели с признаками линейной регрессии 128

6.1. Практикум: моделирование количественного соотношения «структура-

активность» 129

6.2. Линейная регрессия 135

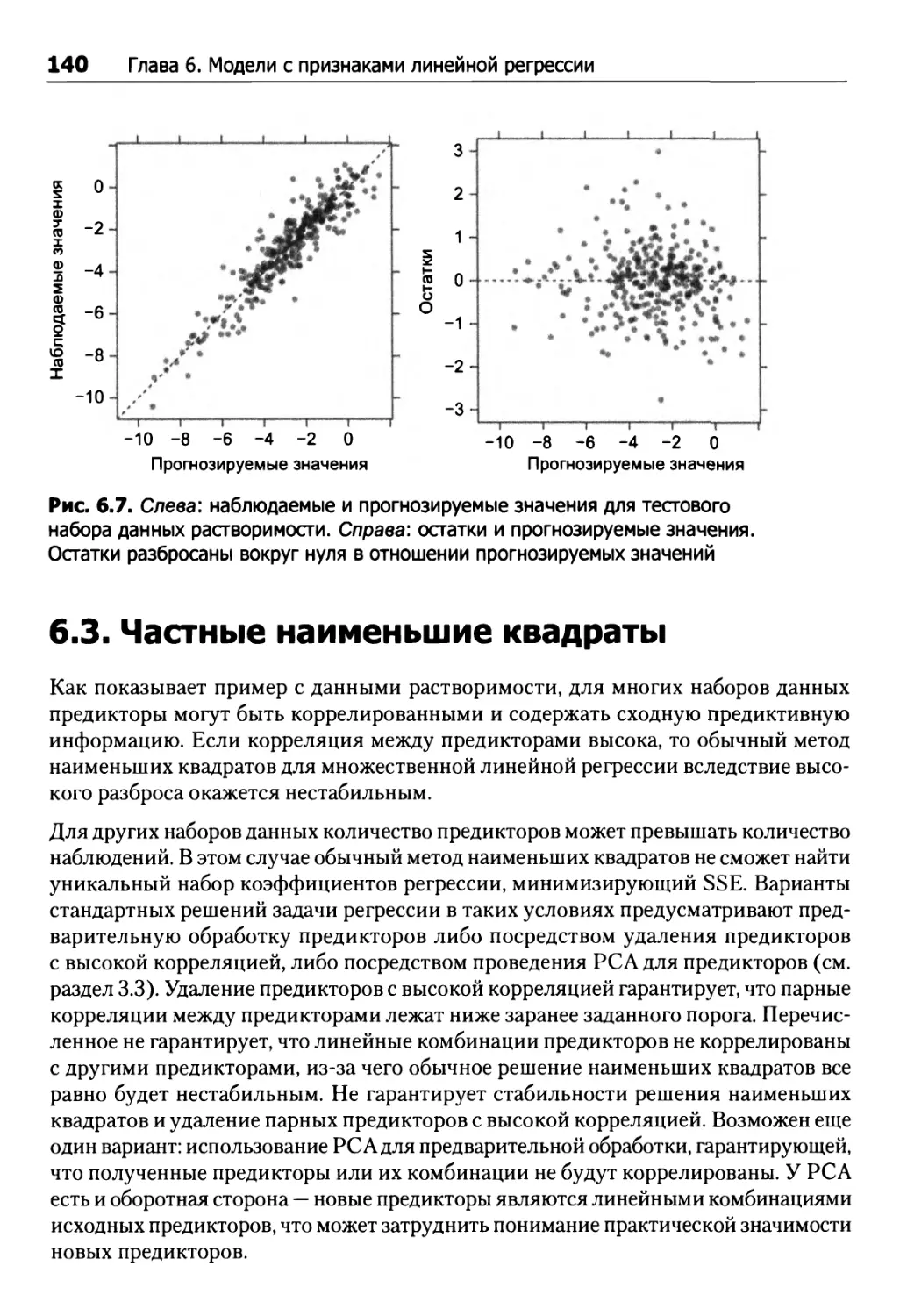

Линейная регрессия для данных растворимости 139

6.3. Частные наименьшие квадраты 140

Применение методов PCR и PLSR для прогнозирования данных растворимости 144

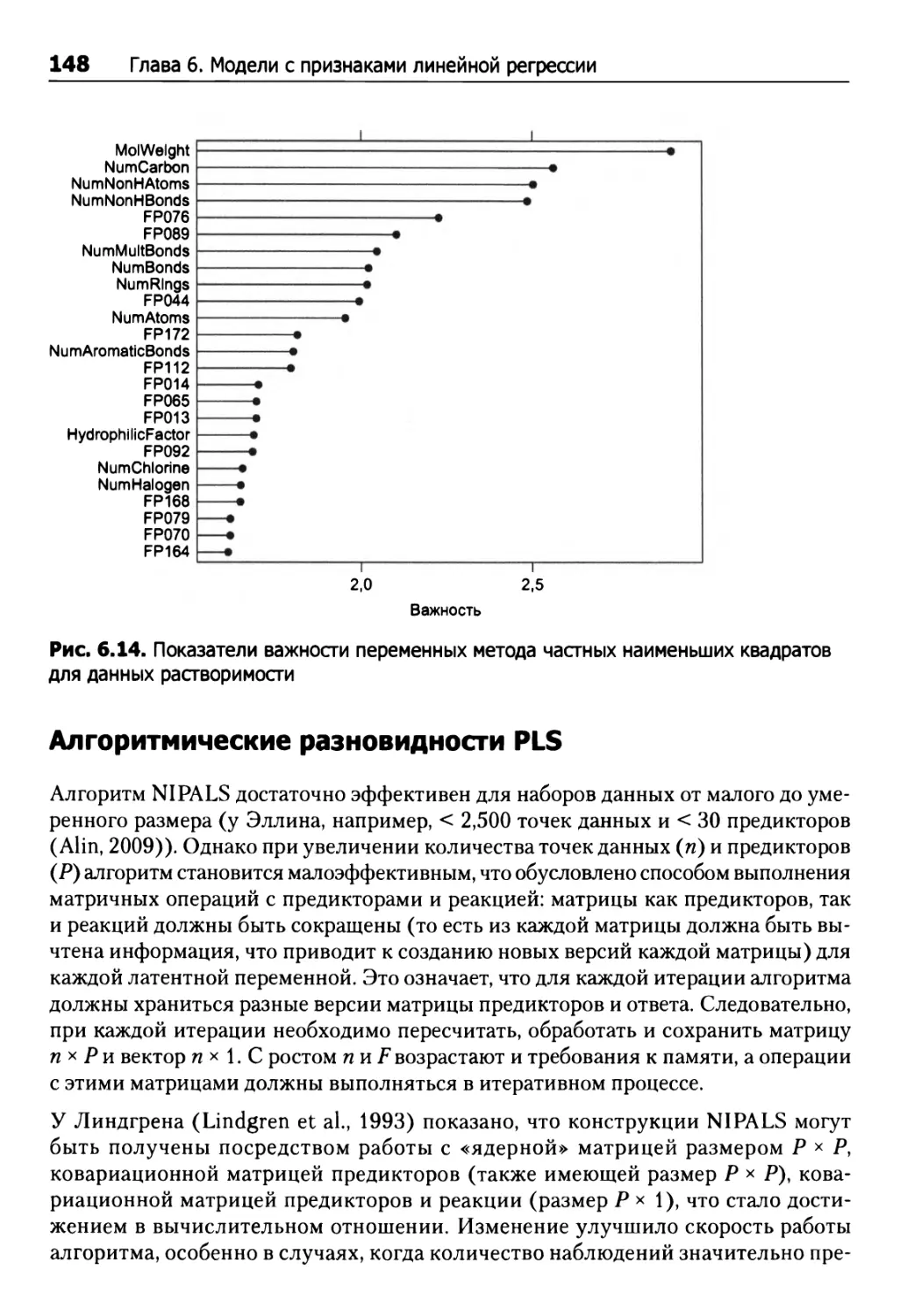

Алгоритмические разновидности PLS 148

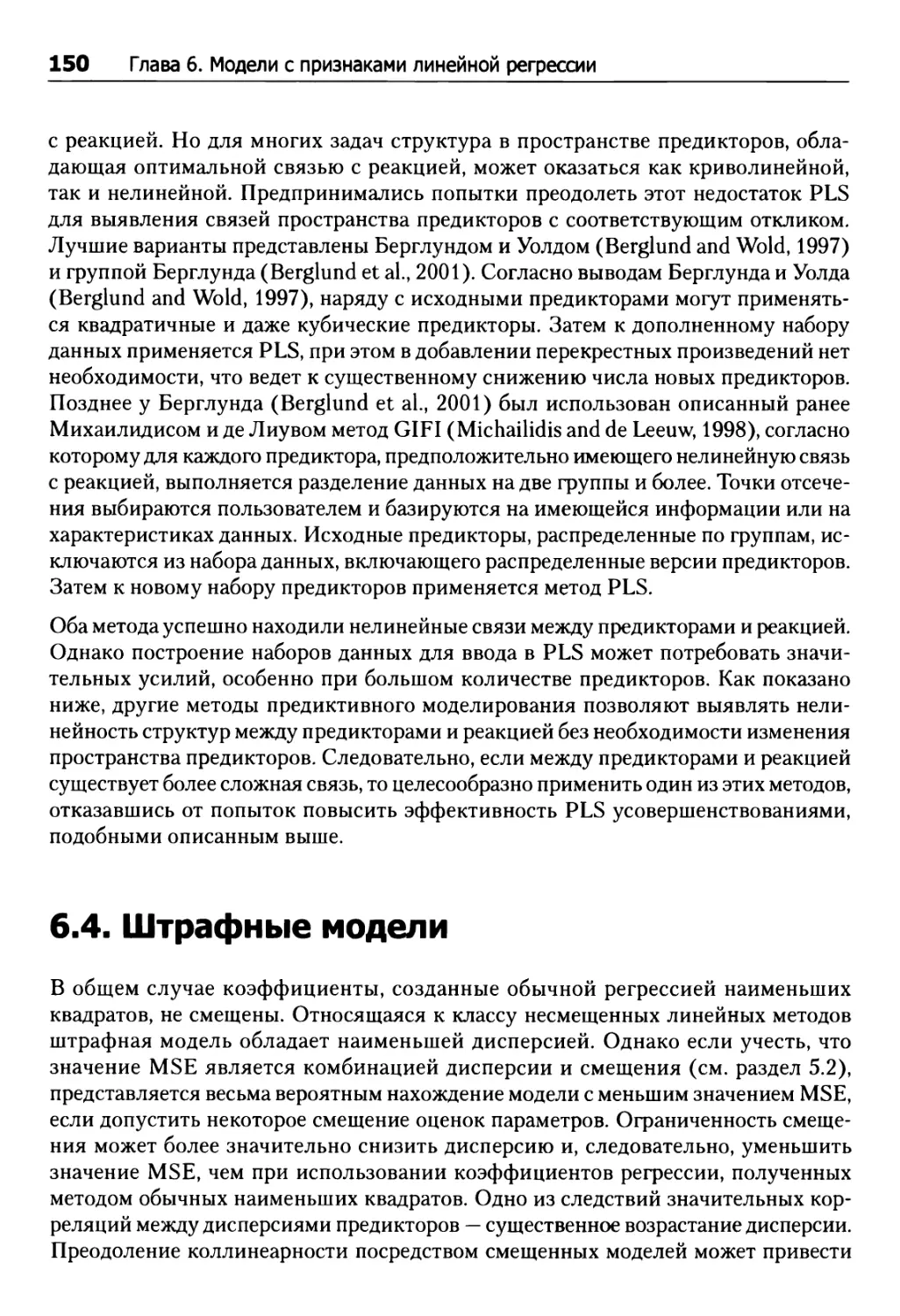

6.4. Штрафные модели 150

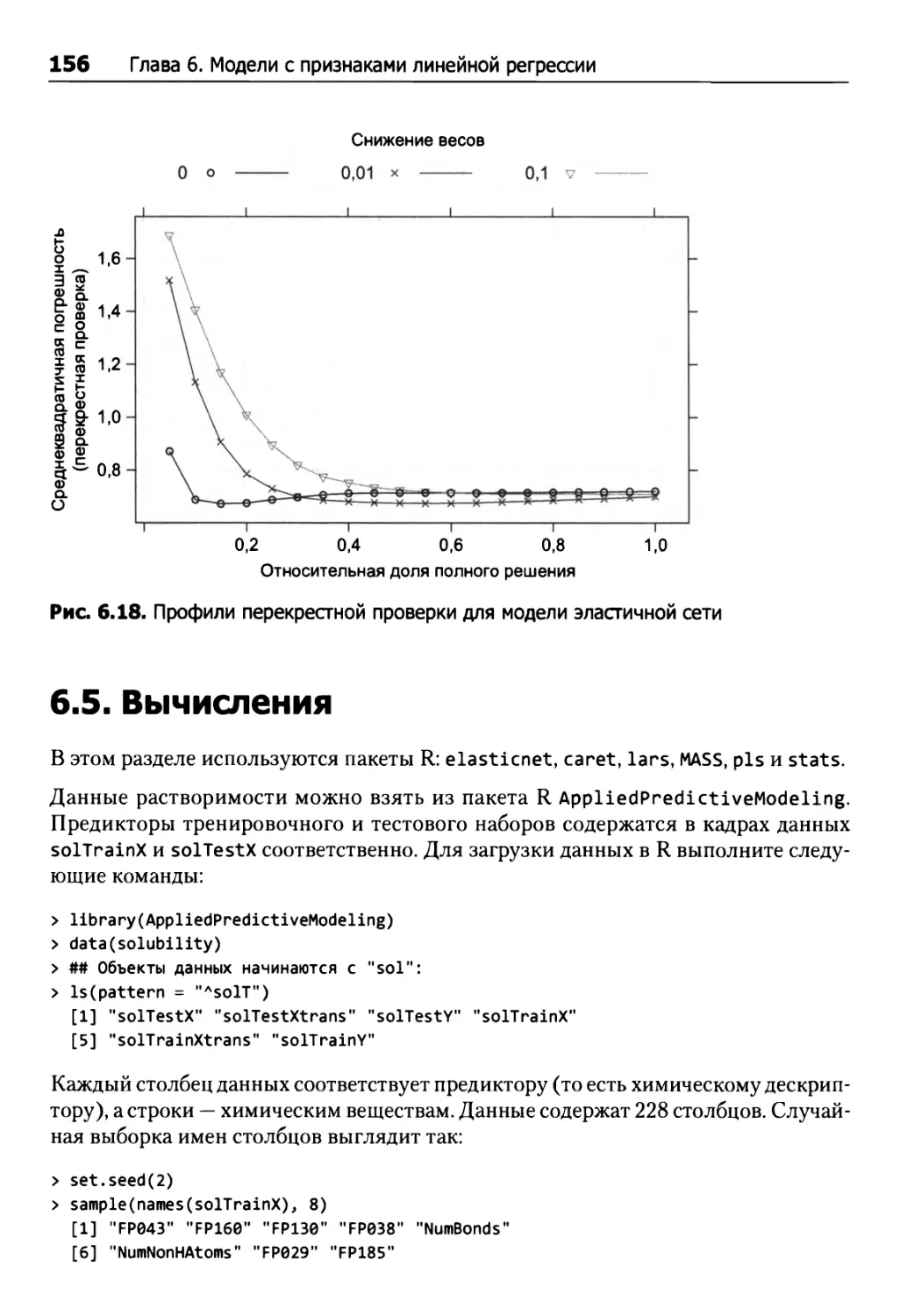

6.5. Вычисления 156

Обычная линейная регрессия 157

Частные наименьшие квадраты 162

Штрафные регрессионные модели 163

Упражнения 166

Глава 7. Нелинейные регрессионные модели 169

7.1. Нейросети 169

7.2. Многомерные адаптивные регрессионные сплайны 174

7.3. SVM, или метод опорных векторов 180

7.4. Метод к ближайших соседей 188

7.5. Вычисления 191

Нейросети 191

Многомерные адаптивные регрессионные сплайны 193

SVM, метод опорных векторов 196

Метод KNN 198

Упражнения 198

Глава 8. Древовидные модели. Модели на базе правил 202

8.1. Базовые деревья регрессии 204

8.2. Деревья регрессионных моделей 214

8.3. Модели на базе правил 221

8.4. Бэггинг-деревья 224

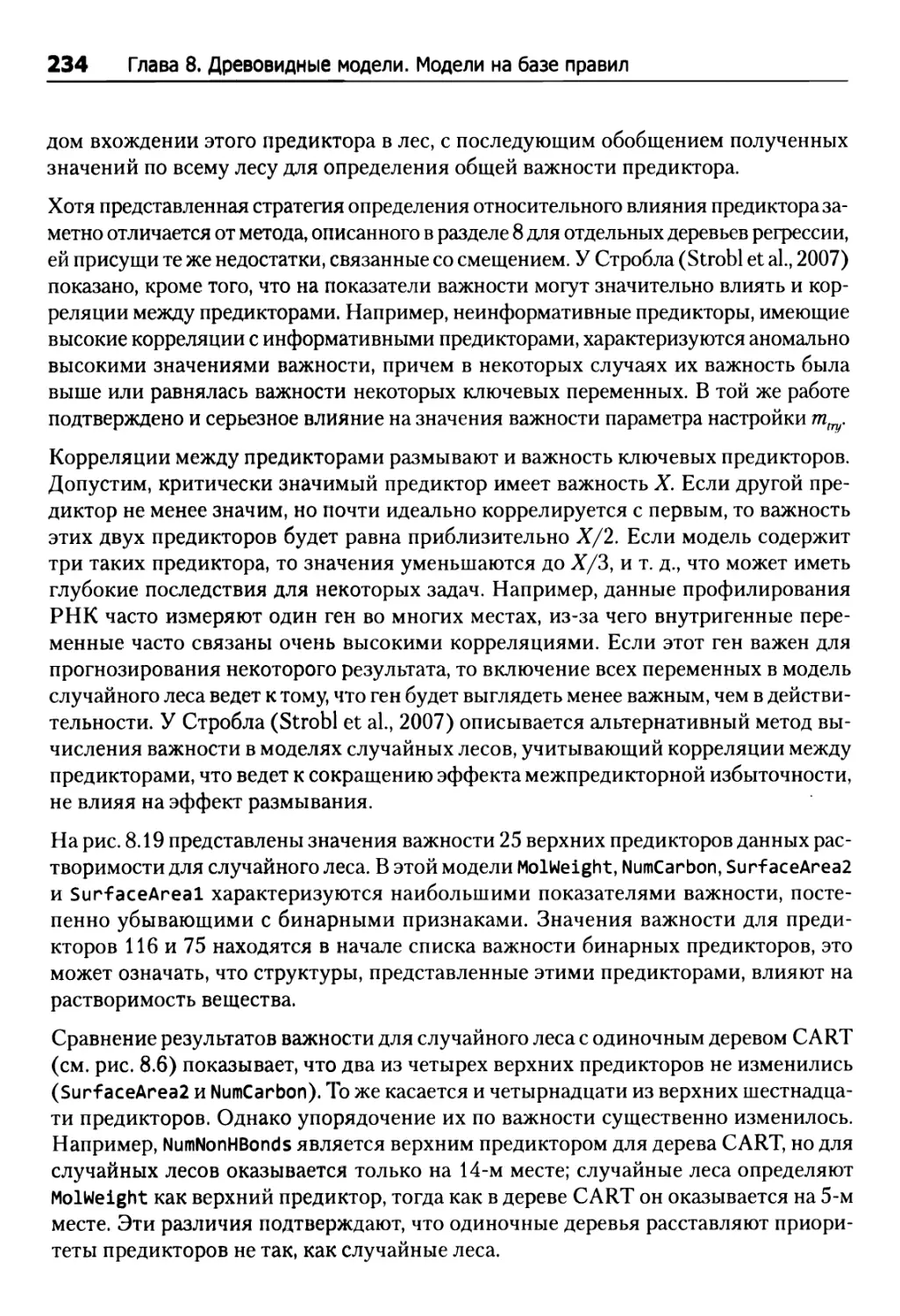

8.5. Случайные леса 230

8.6. Усиление 235

8.7. Модель Cubist 241

8.8. Вычисления 246

Простые деревья 246

Деревья моделей 247

Деревья бэггинга 248

Случайные леса 248

Усиленные деревья 249

Модель Cubist 250

Упражнения 250

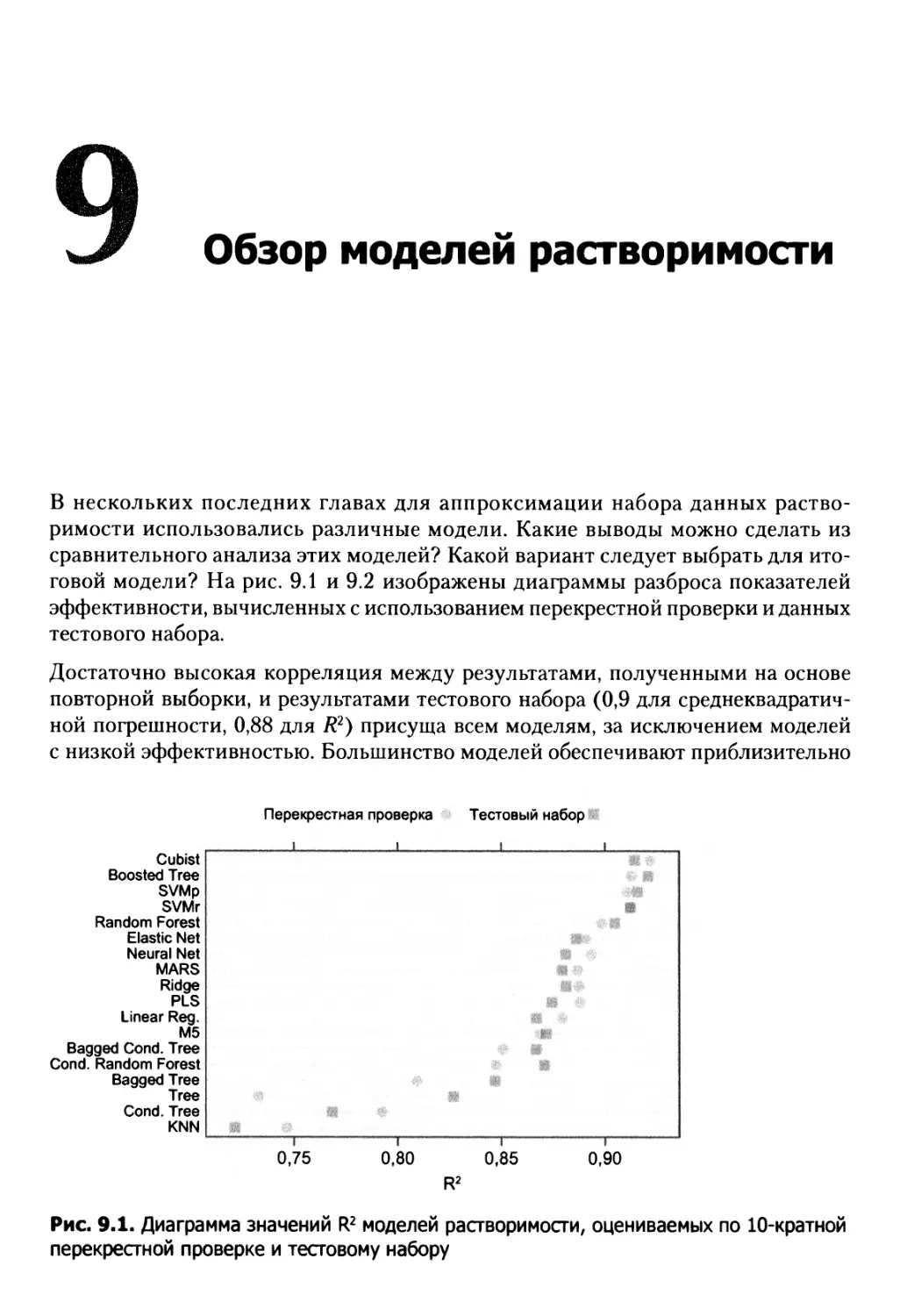

Глава 9. Обзор моделей растворимости 254

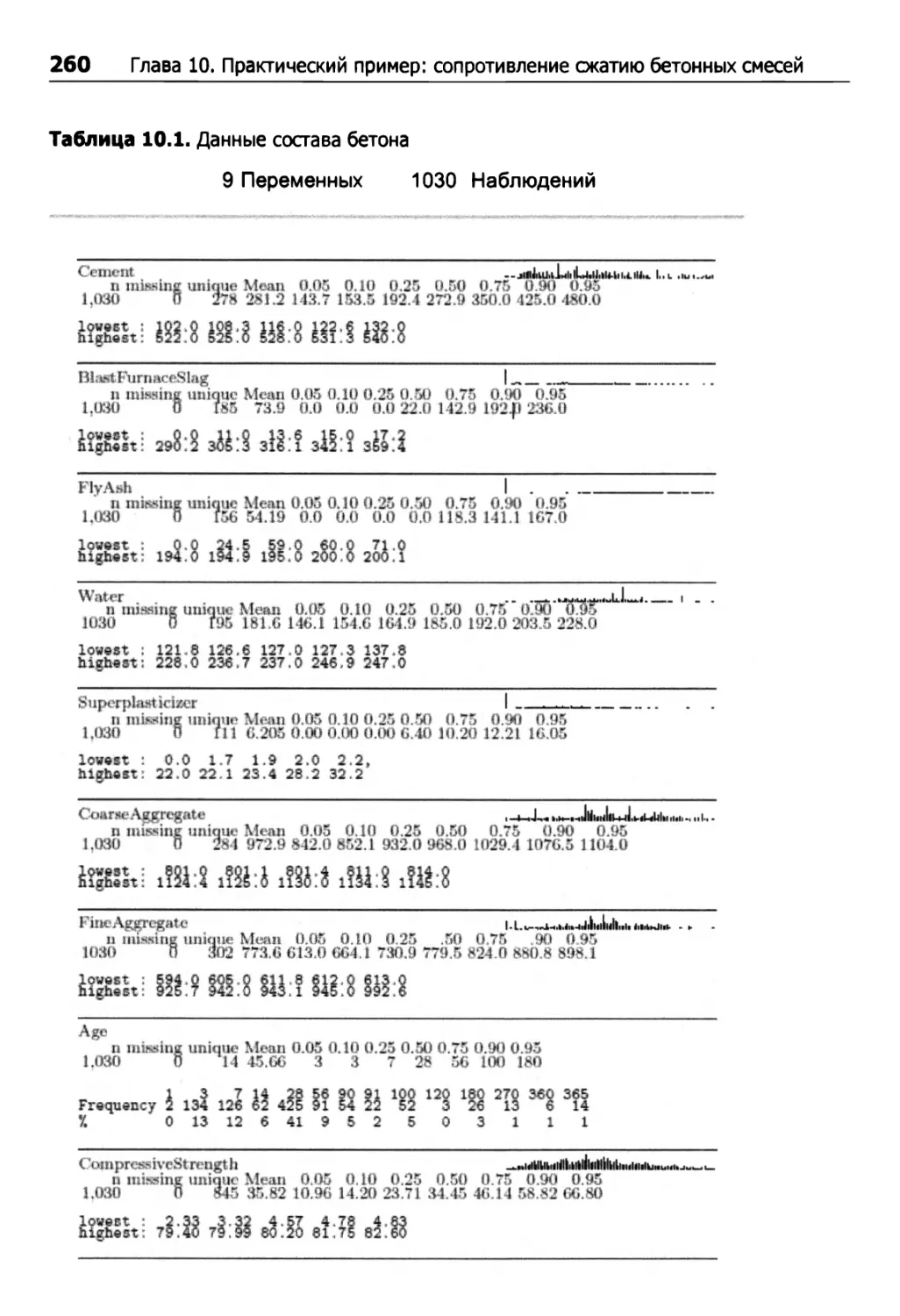

Глава 10. Практический пример: сопротивление сжатию бетонных смесей 257

10.1. Стратегия построения модели 261

10.2. Эффективность моделей 262

10.3. Оптимизация сопротивления сжатию 265

10.4. Вычисления 269

ЧАСТЬ III КЛАССИФИКАЦИОННЫЕ МОДЕЛИ

Глава 11. Определение эффективности в классификационных моделях 278

11.1. Прогнозы классов 278

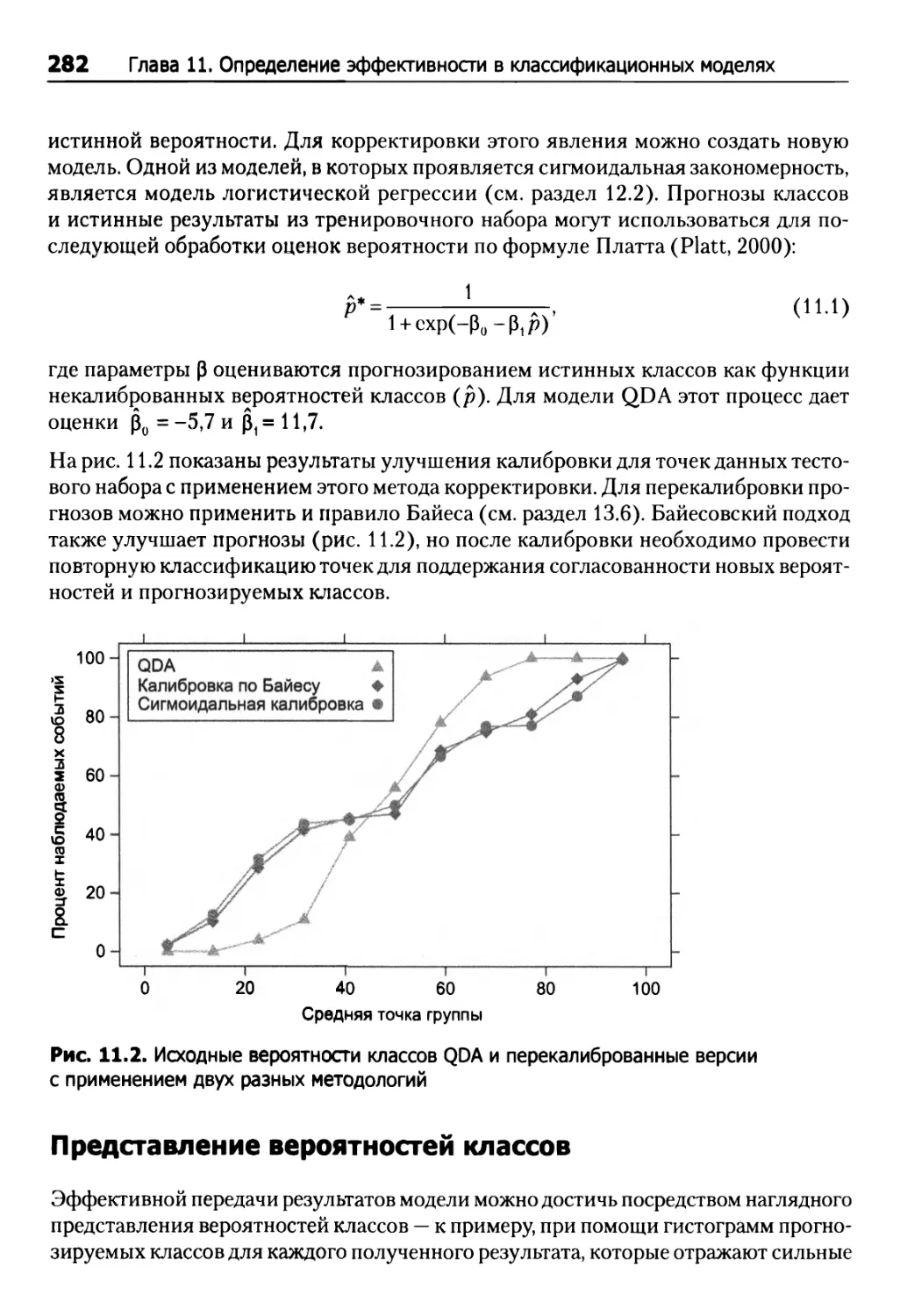

Хорошо откалиброванные вероятности 280

Представление вероятностей классов 282

Неоднозначные зоны 284

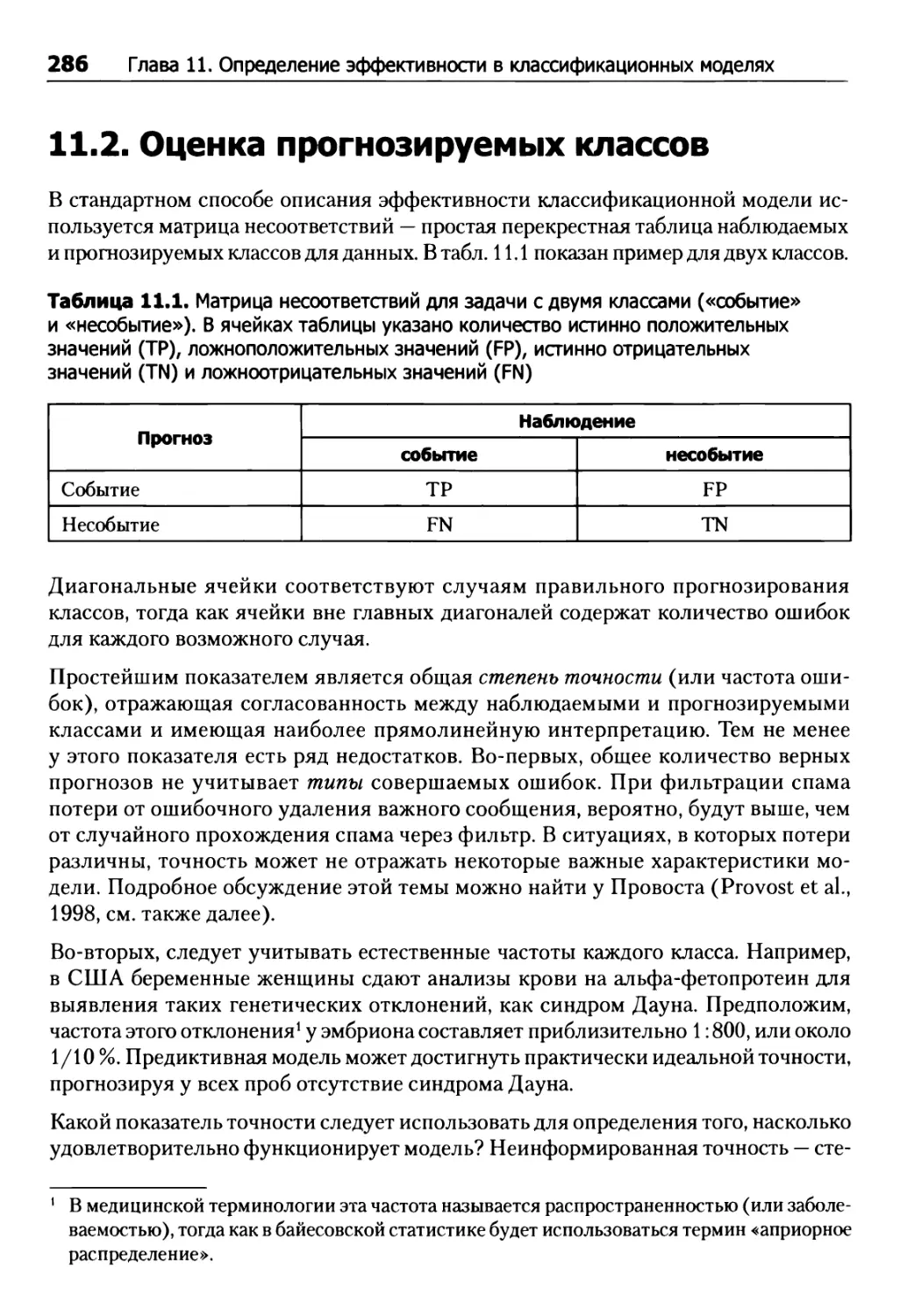

11.2. Оценка прогнозируемых классов 286

Задача двух классов 288

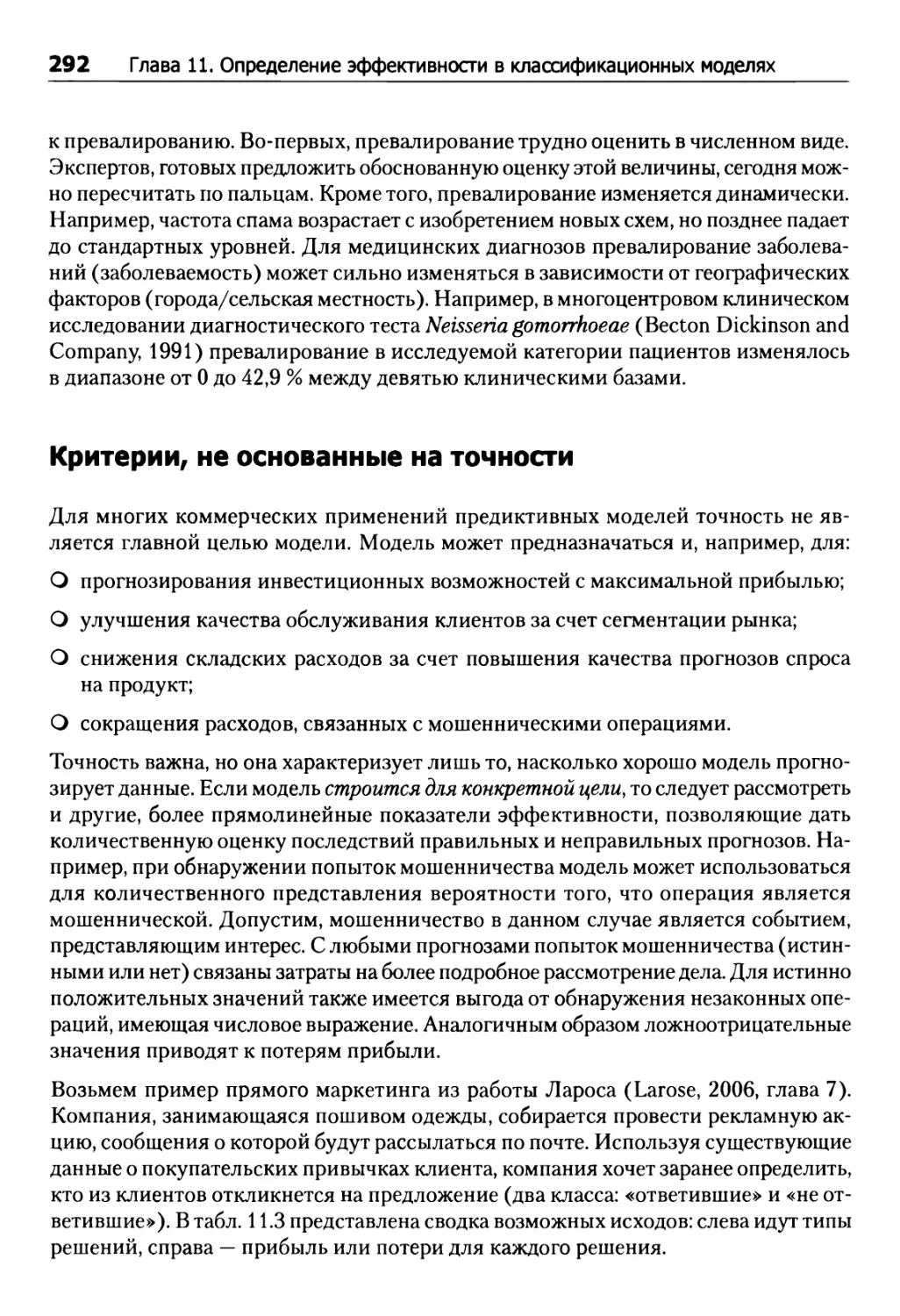

Критерии, не основанные на точности 292

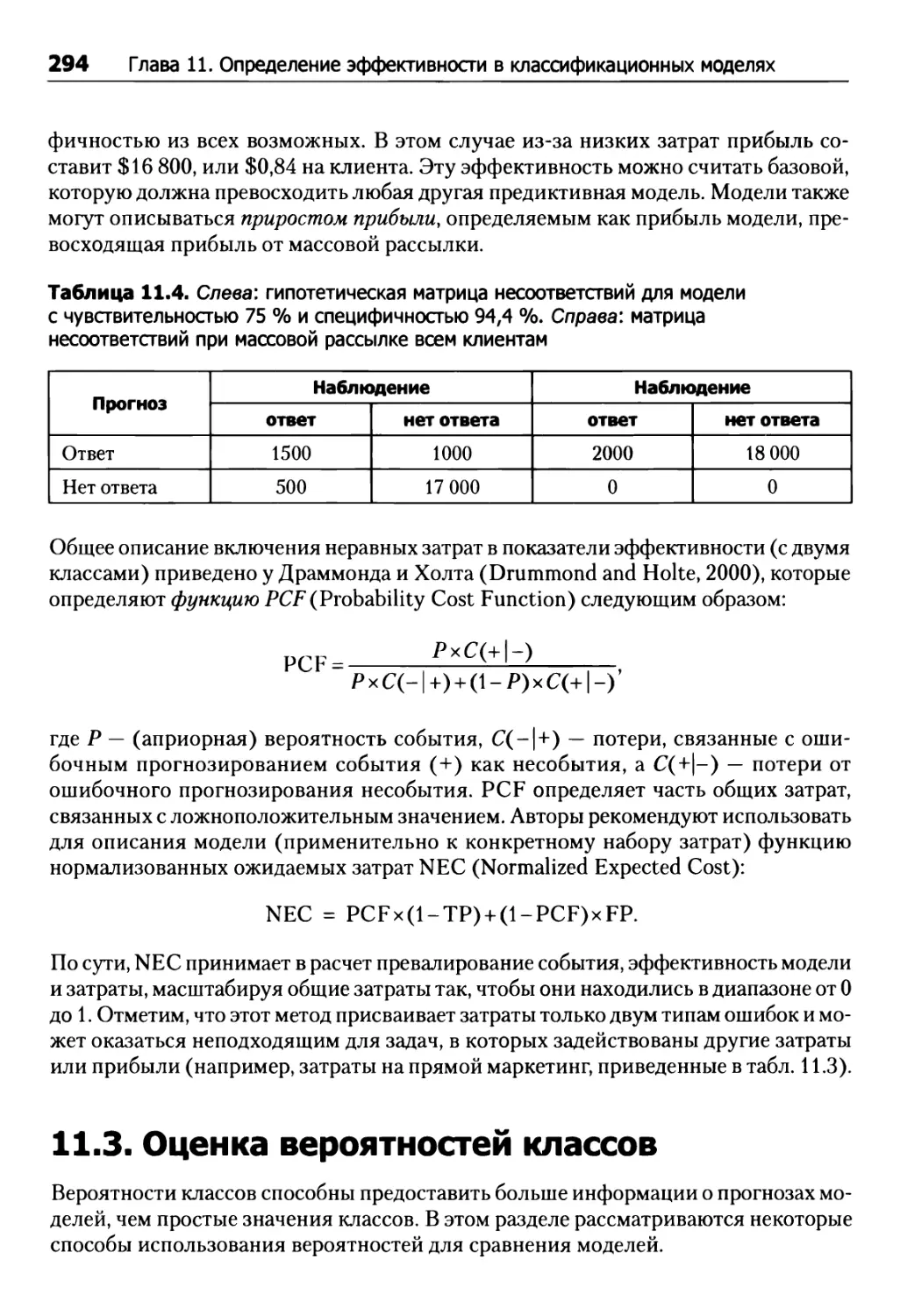

11.3. Оценка вероятностей классов 294

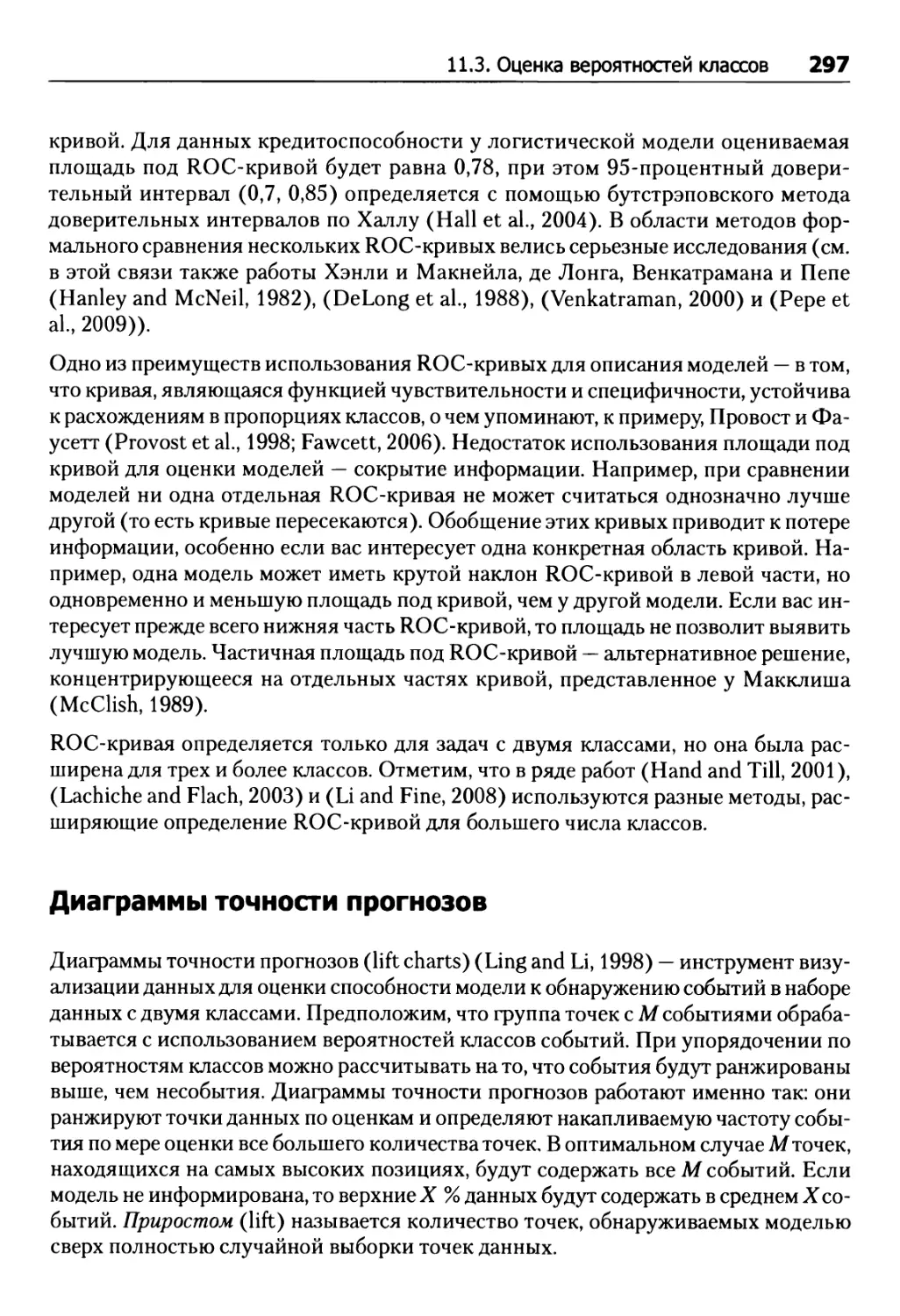

ROC-кривые 295

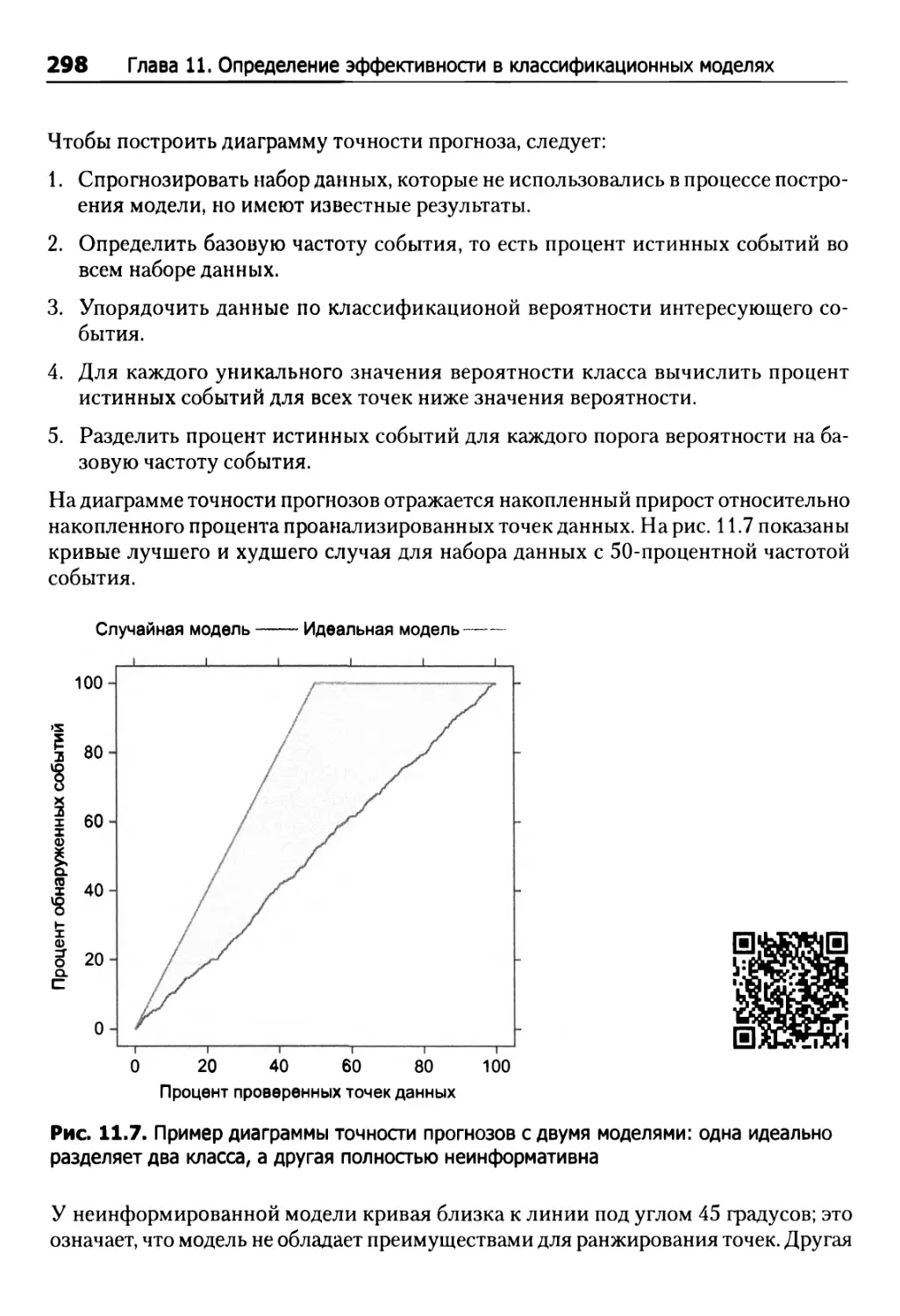

Диаграммы точности прогнозов 297

11.4. Вычисления 299

Чувствительность и специфичность 301

Матрица несоответствий 301

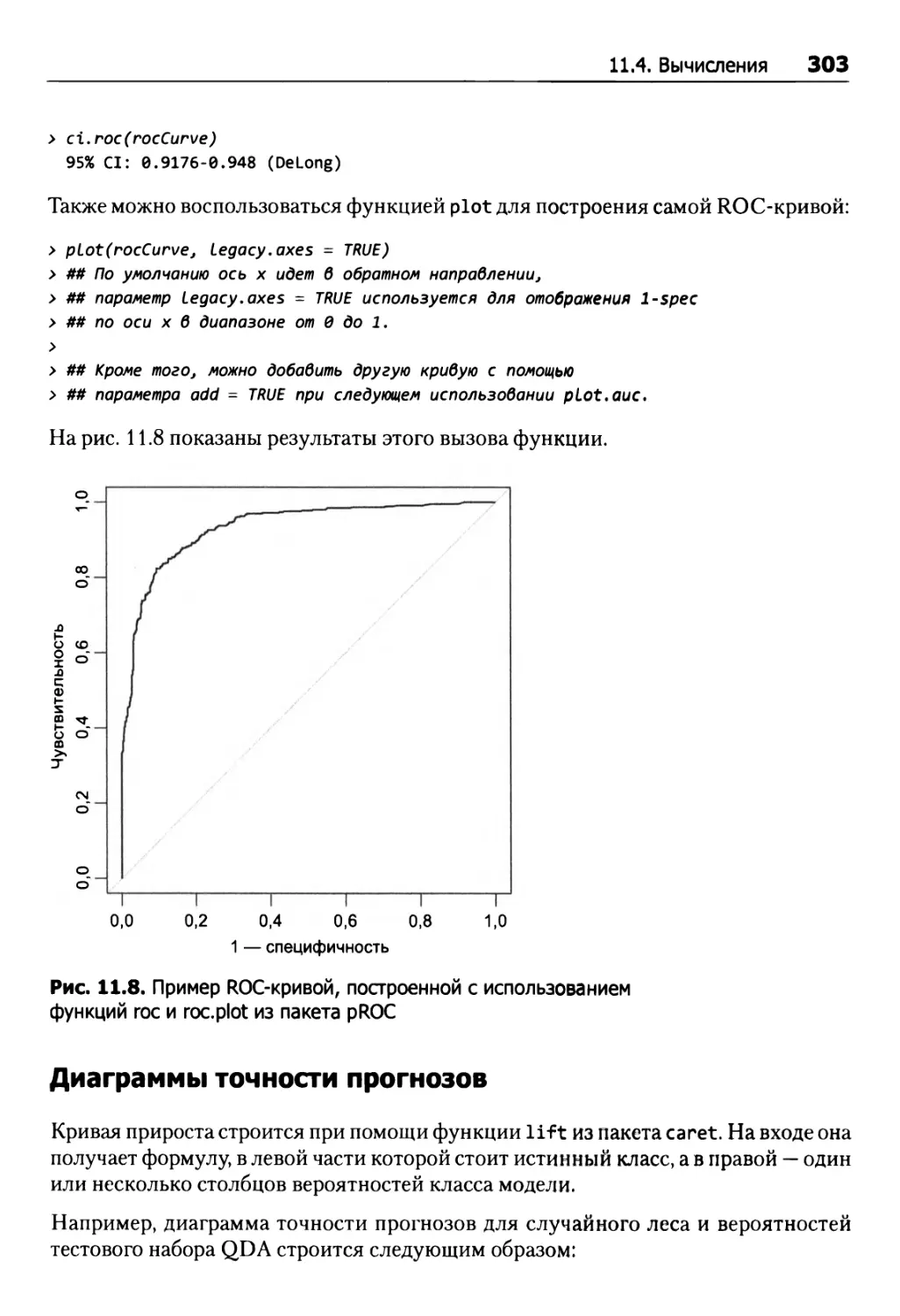

ROC-кривые 302

Диаграммы точности прогнозов 303

Калибровка вероятностей 304

Глава 12. Дискриминантный анализ и другие линейные классификационные модели 307

12.1. Практикум: прогнозирование успешных заявок на получение грантов 307

12.2. Логистическая регрессия 315

12.3. Линейный дискриминантный анализ (LDA) 320

12.4. Дискриминантный анализ методом частных наименьших квадратов 331

12.5. Штрафные модели 337

12.6. Ближайшие сжатые центроиды 341

12.7. Вычисления 344

Логистическая регрессия 347

Линейный дискриминантный анализ 353

Дискриминантный анализ методом частных наименьших квадратов 355

Штрафные модели 357

Метод ближайших сжатых центроидов 359

Упражнения 362

Глава 13. Нелинейные классификационные модели 365

13.1. Нелинейный дискриминантный анализ 365

Квадратичный и регуляризированный дискриминантный анализ 365

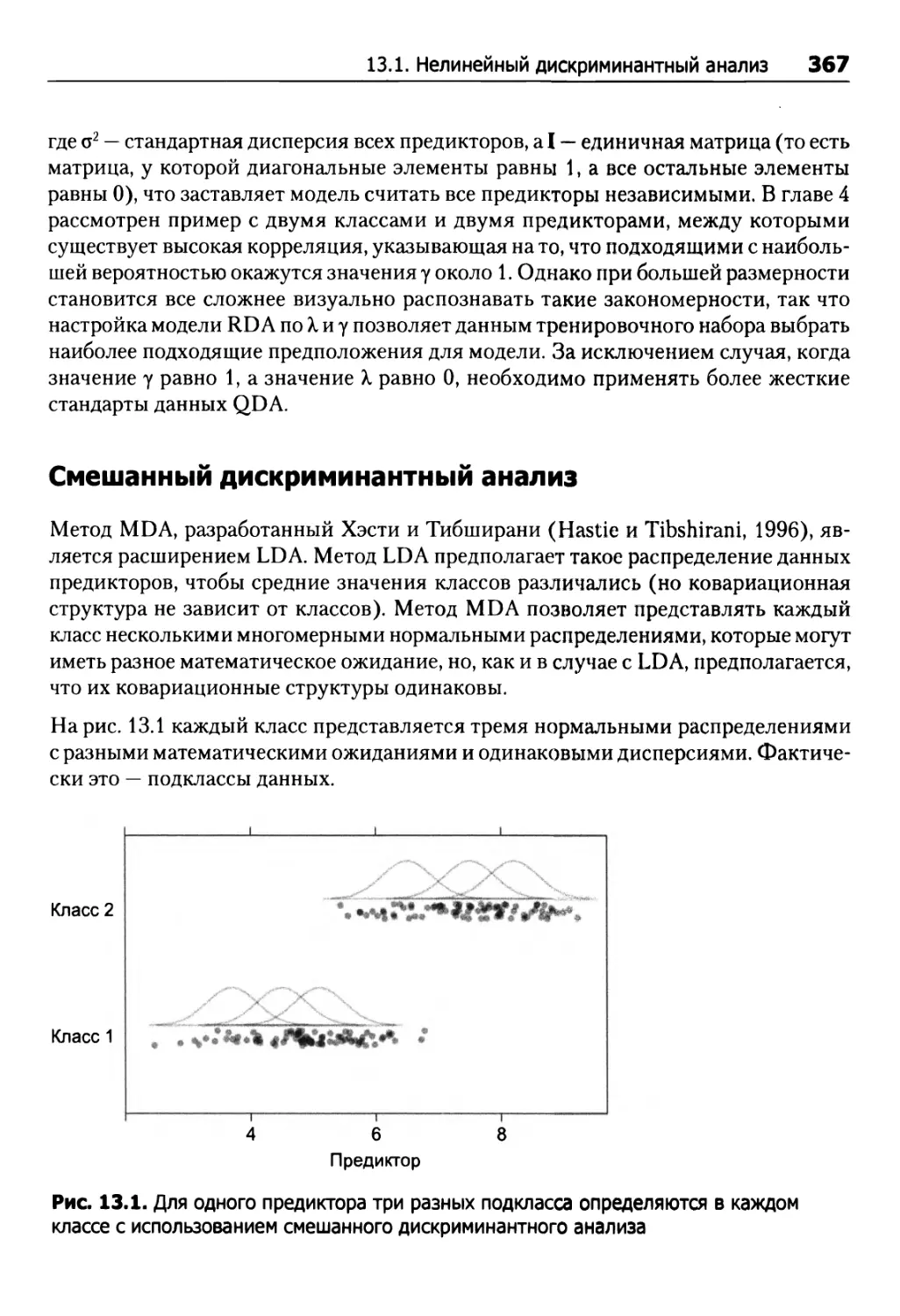

Смешанный дискриминантный анализ 367

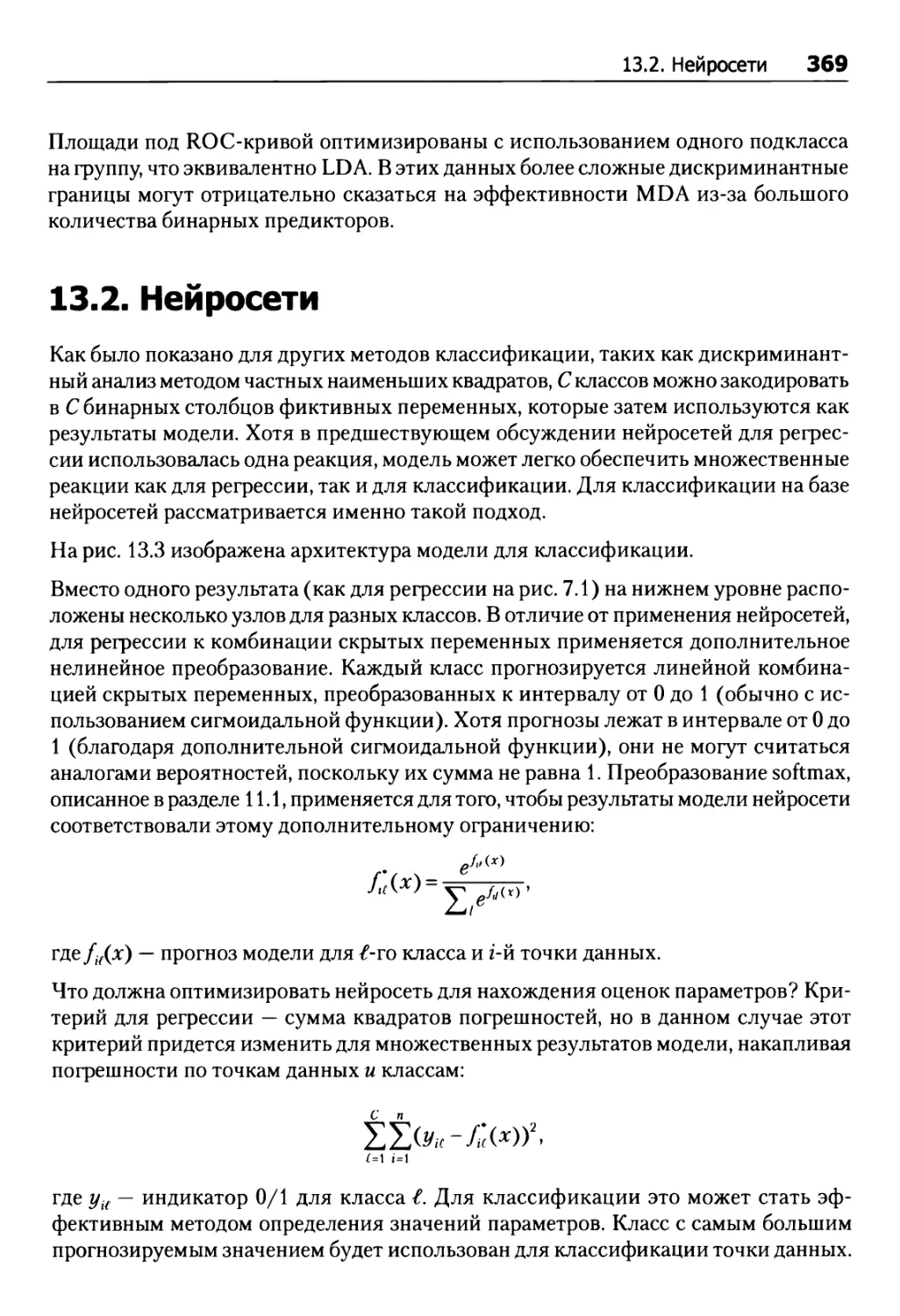

13.2. Нейросети 369

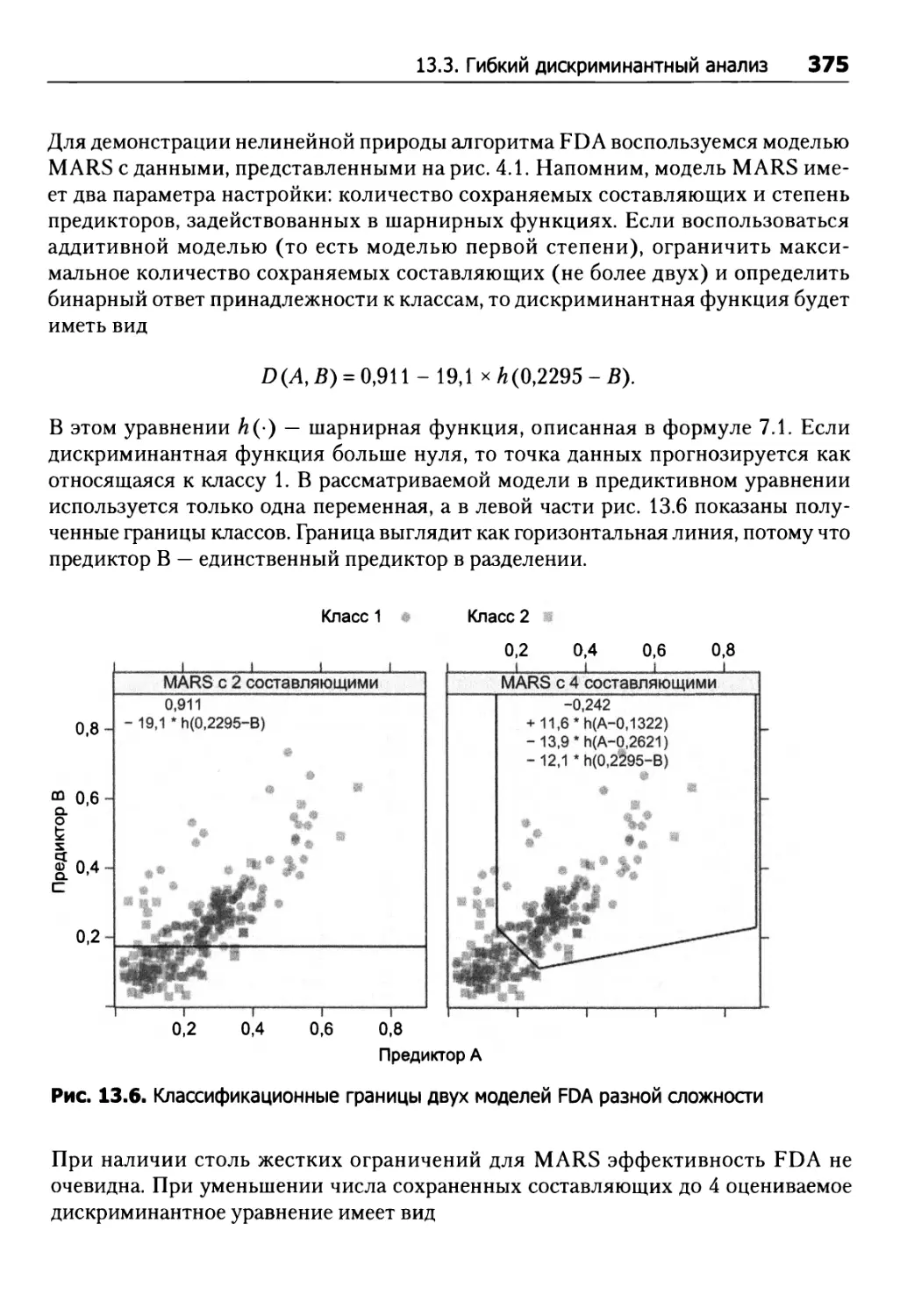

13.3. Гибкий дискриминантный анализ 374

13.4. SVM, метод опорных векторов 380

13.5. Метод KNN 389

13.6. Наивный байесовский классификатор 391

13.7. Вычисления 396

Нелинейный дискриминантный анализ 397

Нейросети 398

FDA 400

Модель SVM 401

Модель KNN (к ближайших соседей) 403

Наивный байесовский классификатор 403

Упражнения 405

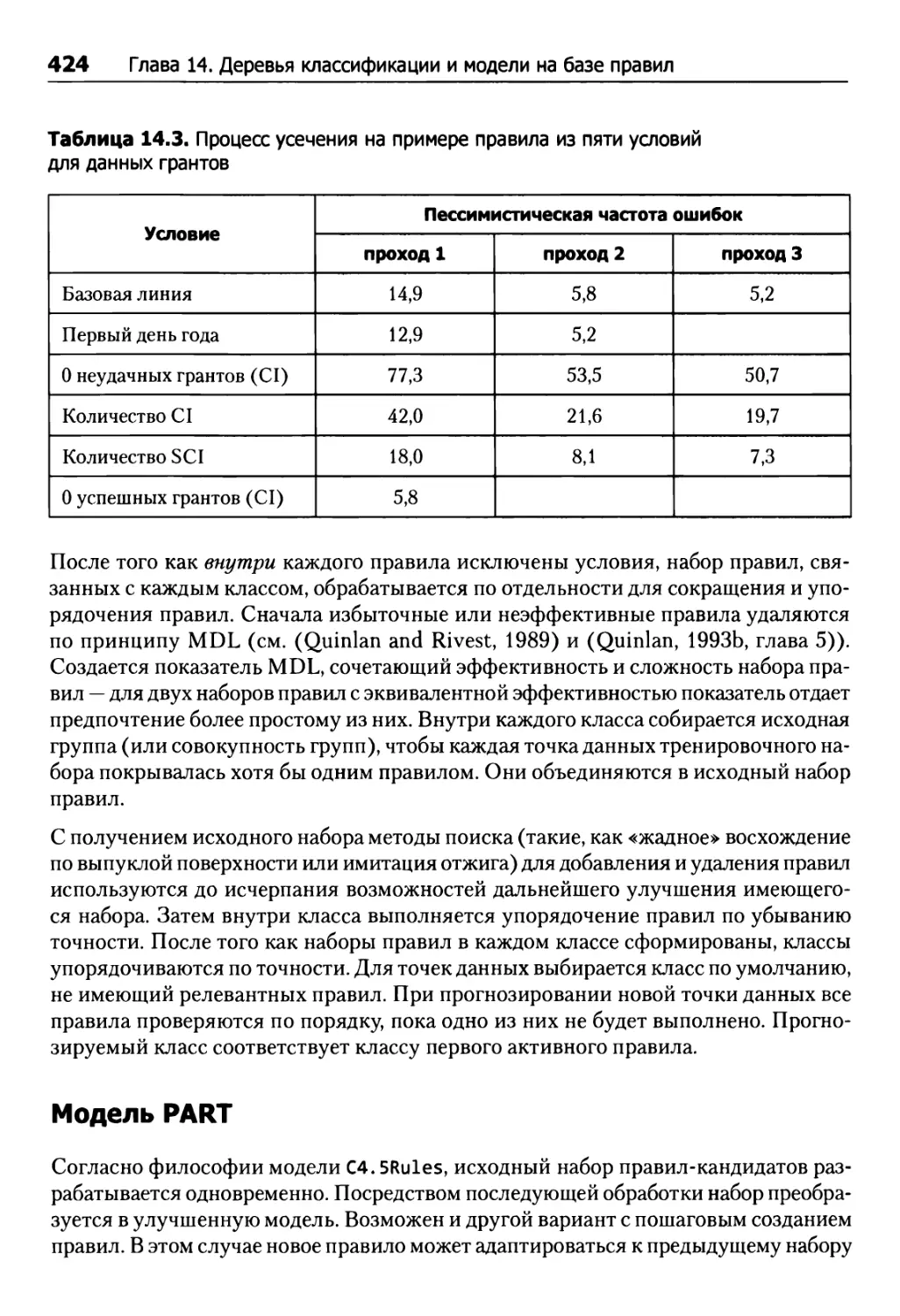

Глава 14. Деревья классификации и модели на базе правил 407

14.1. Базовые деревья классификации 408

14.2. Модели на базе правил 423

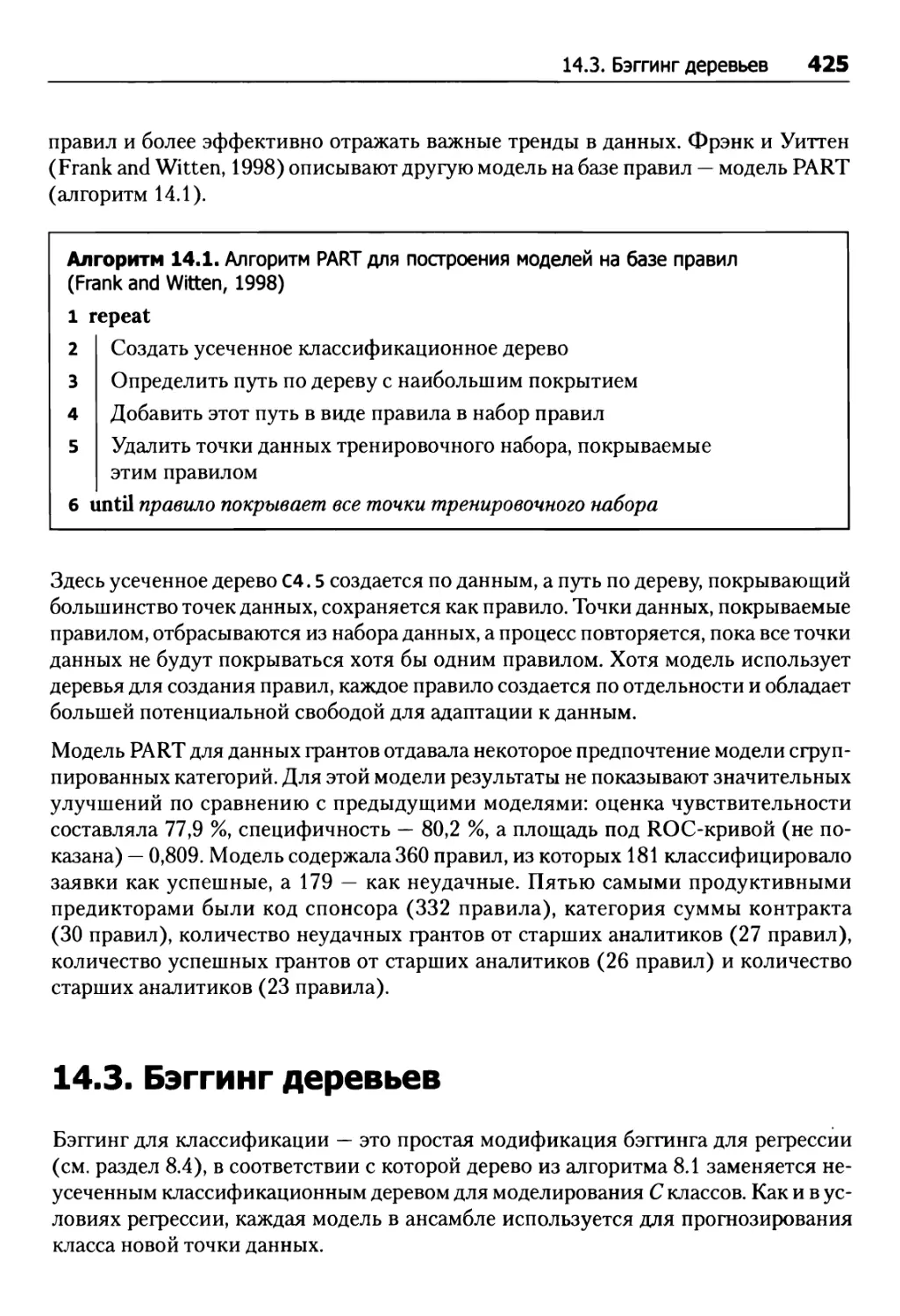

Модель C4.5Rules 423

Модель PART 424

14.3. Бэггинг деревьев 425

14.4. Случайные леса 427

14.5. Бустинг 429

Алгоритм AdaBoost 429

Стохастический градиентный бустинг 431

14.6. Модель С5.0 434

Классификационные деревья 435

Правила классификации 436

Усиление 437

Другие аспекты модели 438

Данные грантов 440

14.7. Сравнение двух кодировок категорийных предикторов 442

14.8. Вычисления 443

Классификационные деревья 443

Правила 447

Деревья с бэггингом 449

Случайный лес 450

Деревья с усилением 451

Упражнения 453

Глава 15. Сравнительный анализ моделей для заявок на получение грантов 456

Глава 16. Решение проблемы дисбаланса классов 460

16.1. Практикум: прогнозирование политики страхования 461

16.2. Эффект дисбаланса классов 462

16.3. Настройка модели 465

16.4. Альтернативные пороги отсечения 465

16.5. Корректировка априорных вероятностей 468

16.6. Неравные веса 469

16.7. Методы выборки 469

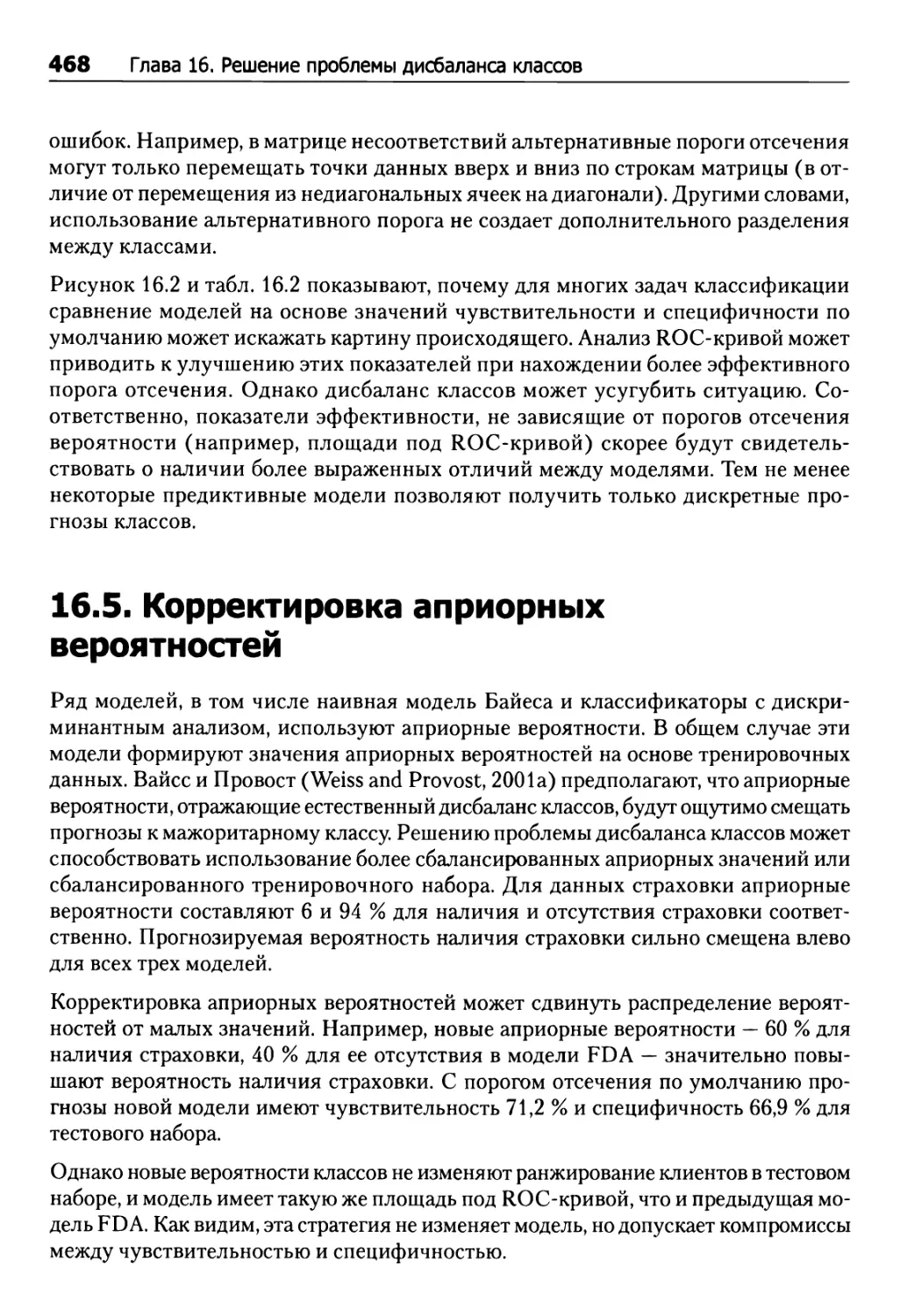

16.8. Тренировка с учетом стоимости 473

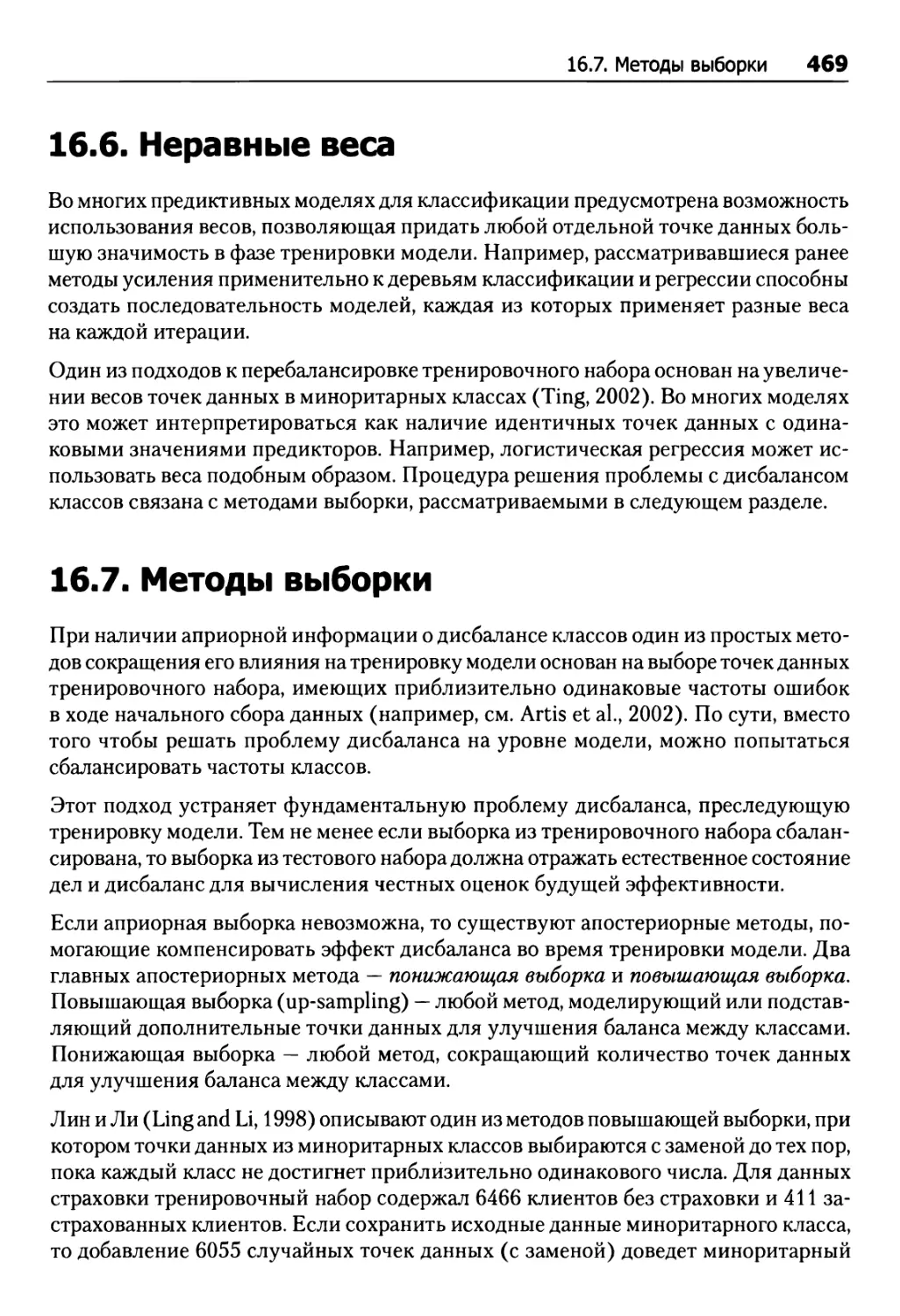

16.9. Вычисления 478

Альтернативные пороги отсечения 482

Методы выборки 482

Тренировка с учетом стоимости 483

Упражнения 486

Глава 17. Практикум: планирование заданий 488

17.1. Разделение данных и стратегия модели 496

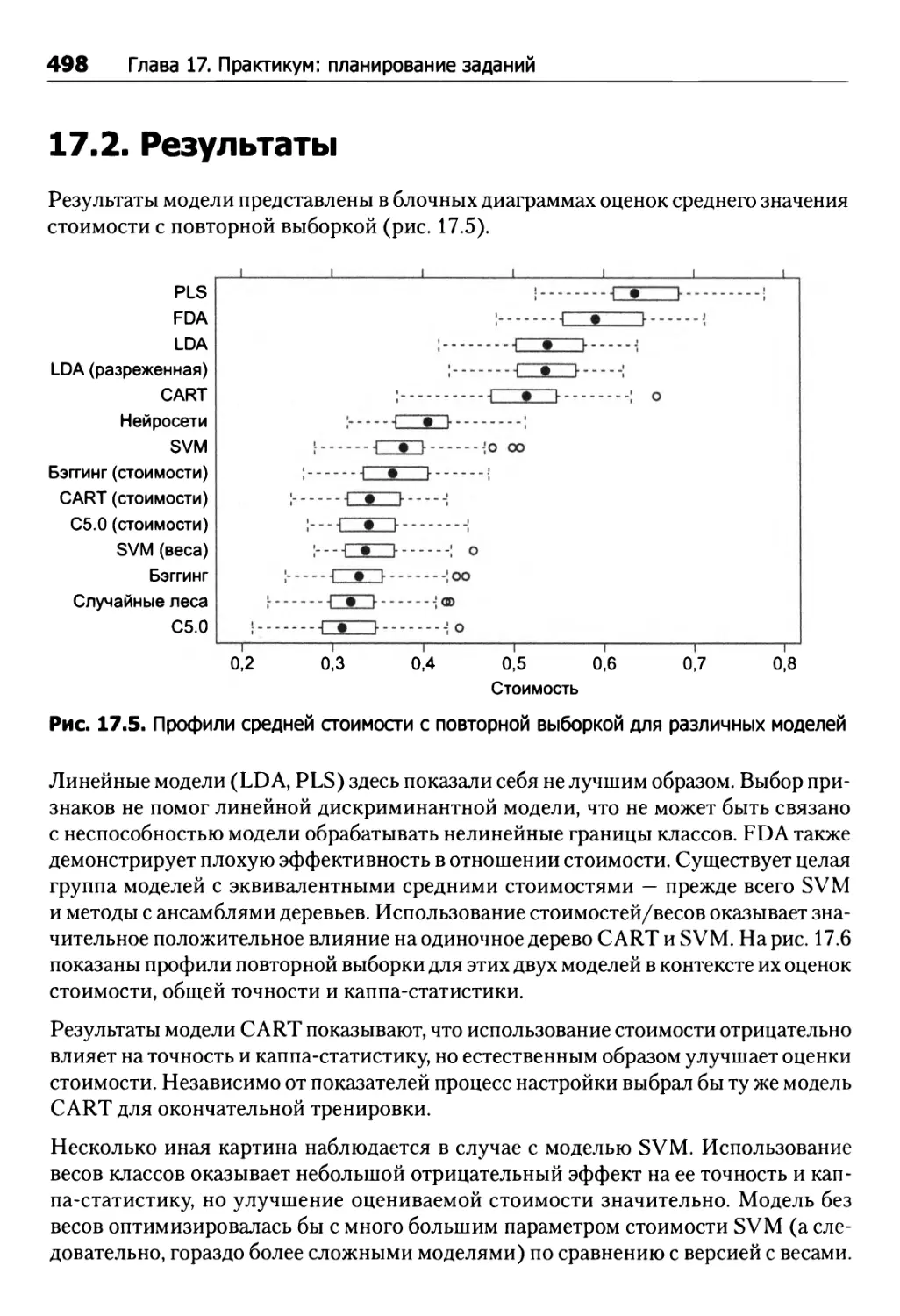

17.2. Результаты 498

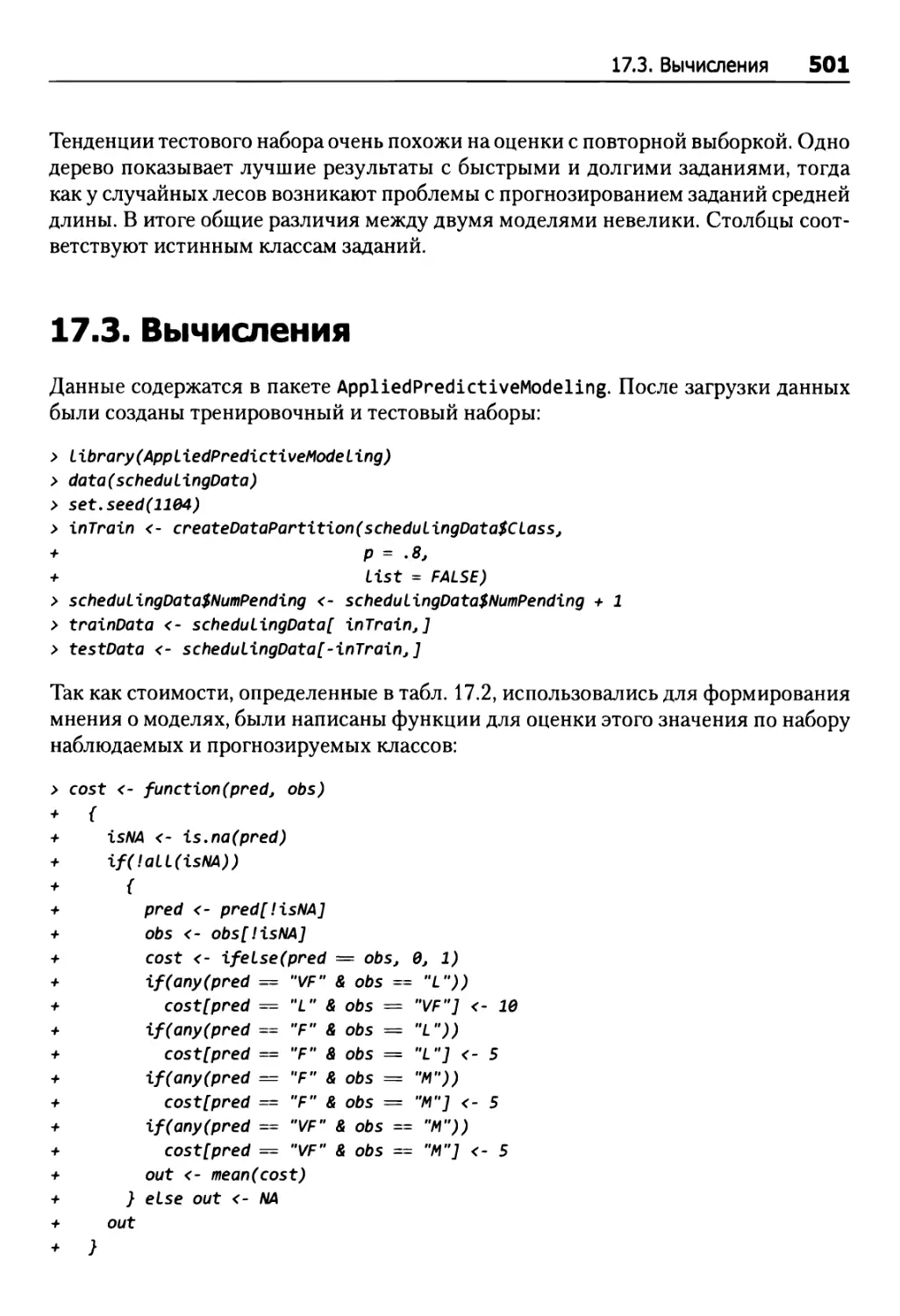

17.3. Вычисления 501

ЧАСТЬ IV

ПРОЧИЕ ВОПРОСЫ ПРЕДИКТИВНОГО МОДЕЛИРОВАНИЯ

Глава 18. Определение важности предикторов 506

18.1. Числовые результаты 507

18.2. Категорийные результаты 511

18.3. Прочие методы 516

18.4. Вычисления 522

Числовые результаты 522

Категорийные результаты 525

Показатели важности для разных моделей 528

Упражнения 529

Глава 19. Выбор признаков 531

19.1. Последствия использования неинформативных предикторов 532

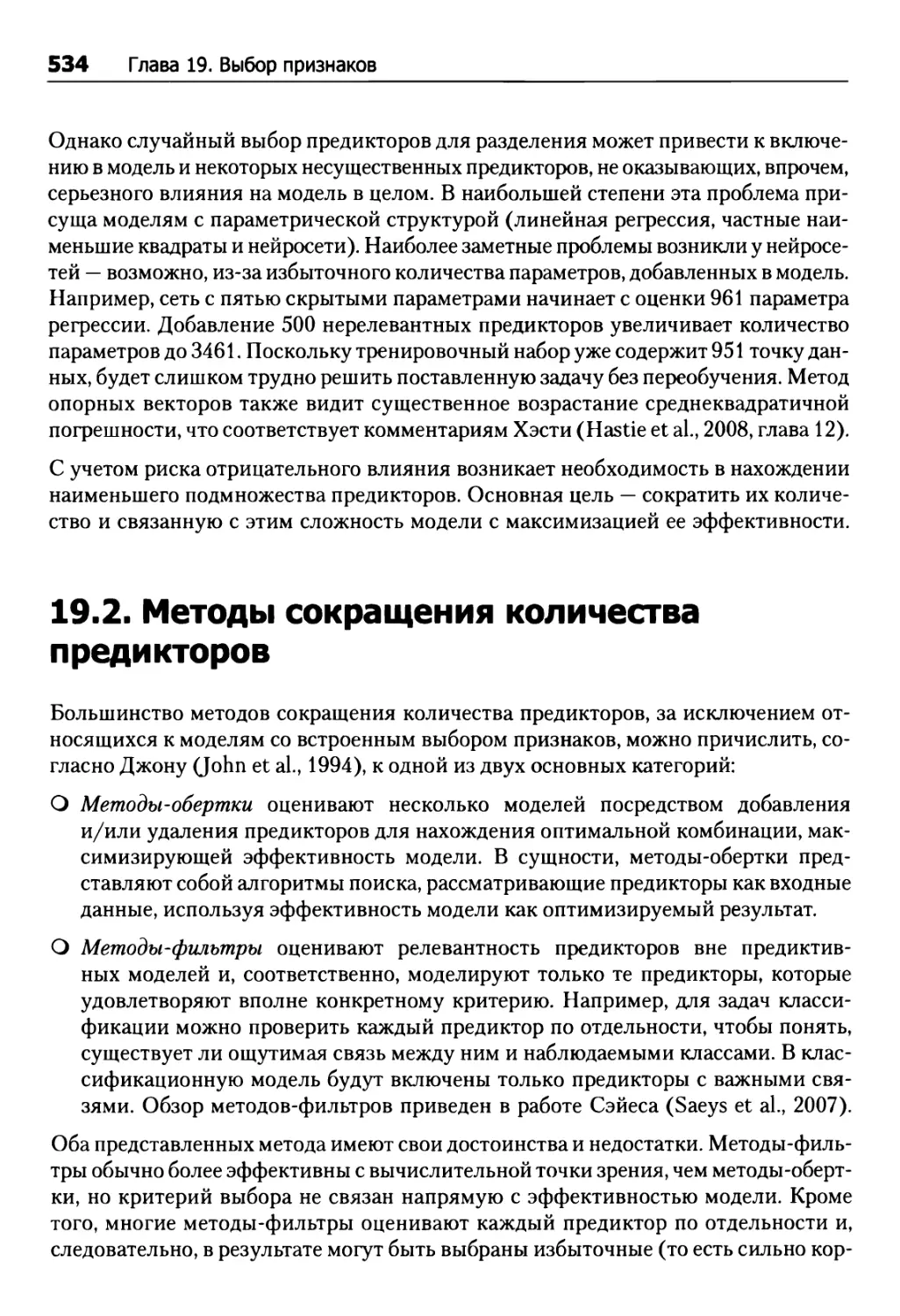

19.2. Методы сокращения количества предикторов 534

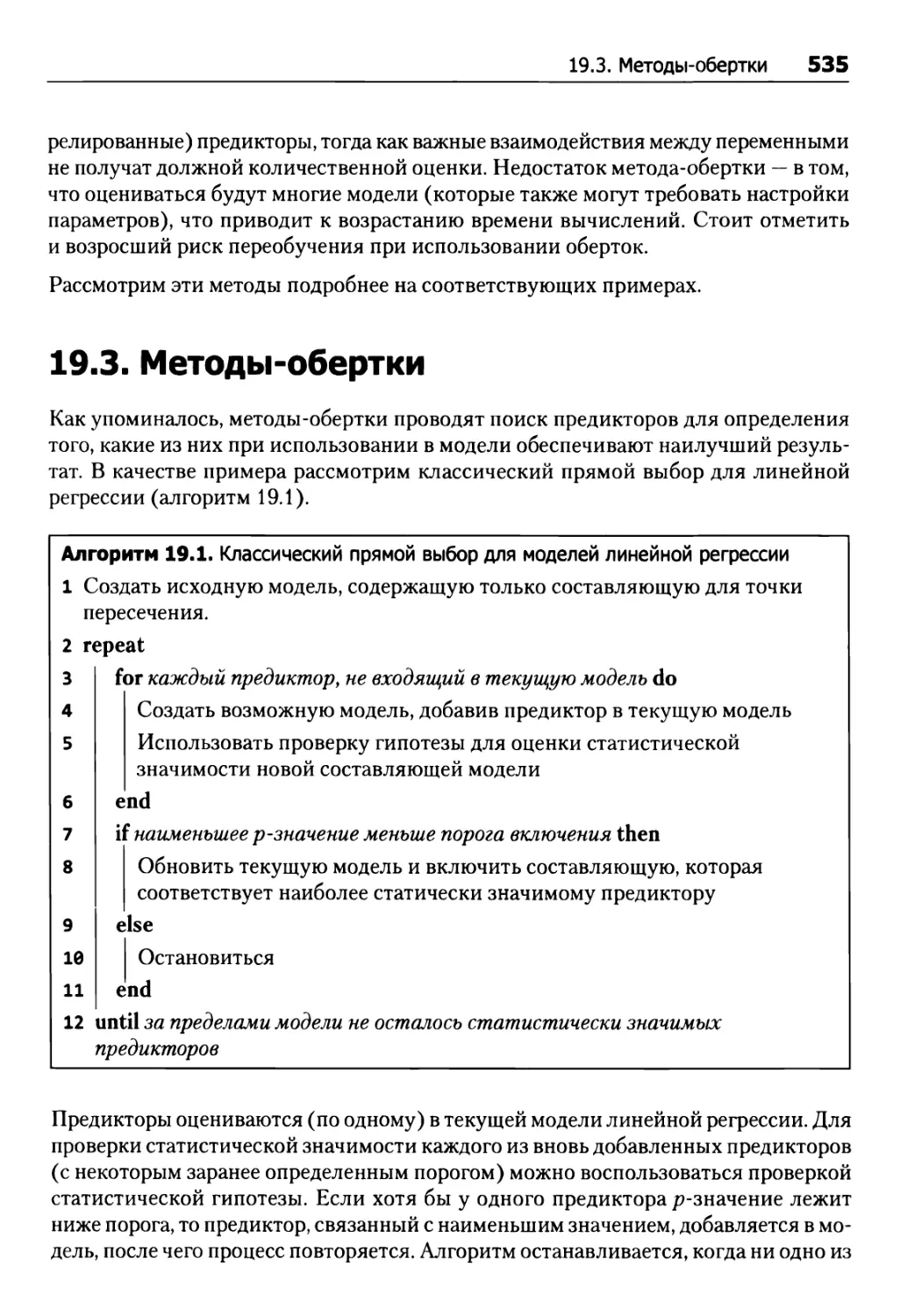

19.3. Методы-обертки 535

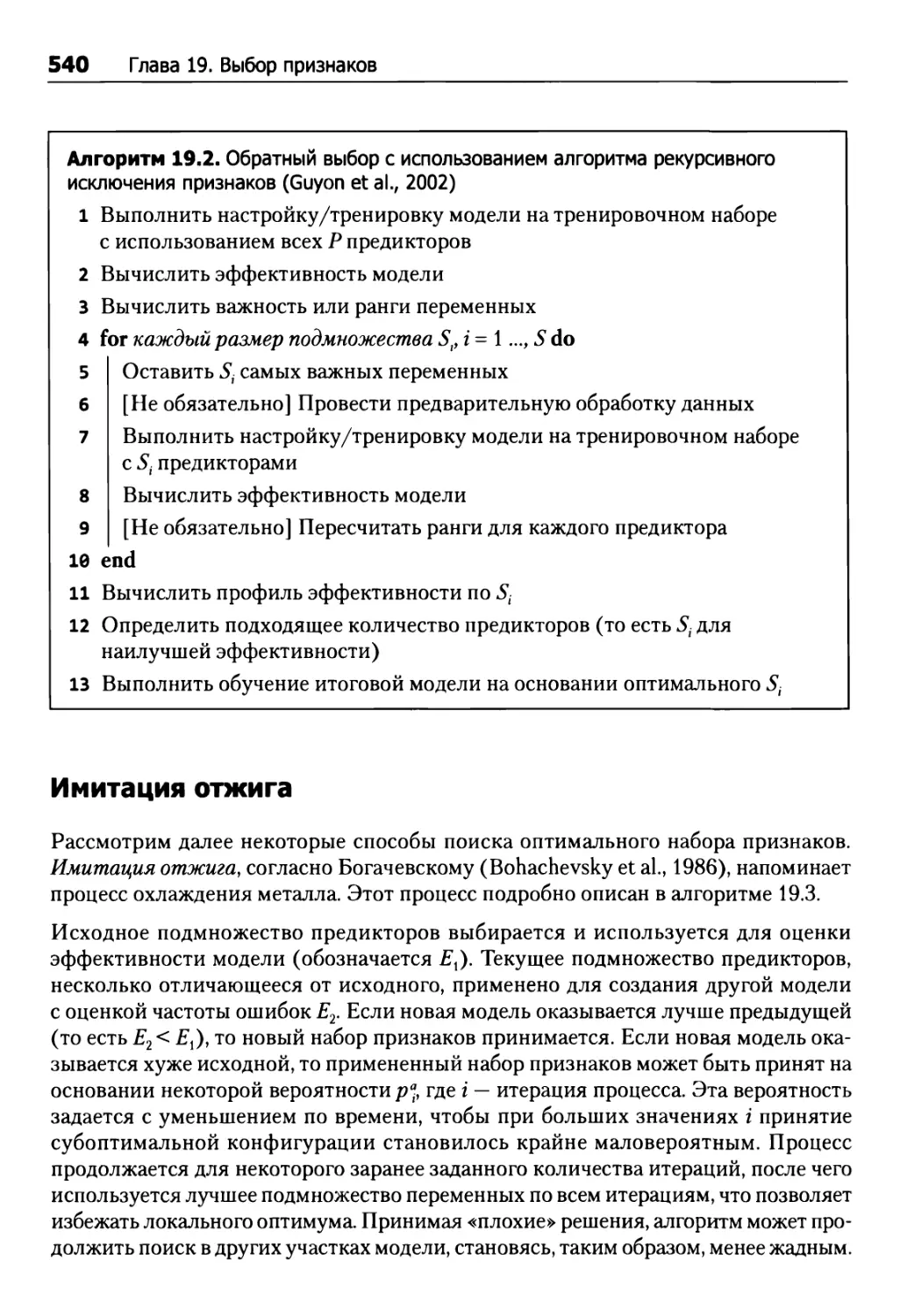

Прямой, обратный и пошаговый выбор 539

Имитация отжига 540

Генетические алгоритмы 541

19.4. Методы-фильтры 544

19.5. Смещение выбора 545

19.6. Практикум: прогнозирование когнитивного расстройства 548

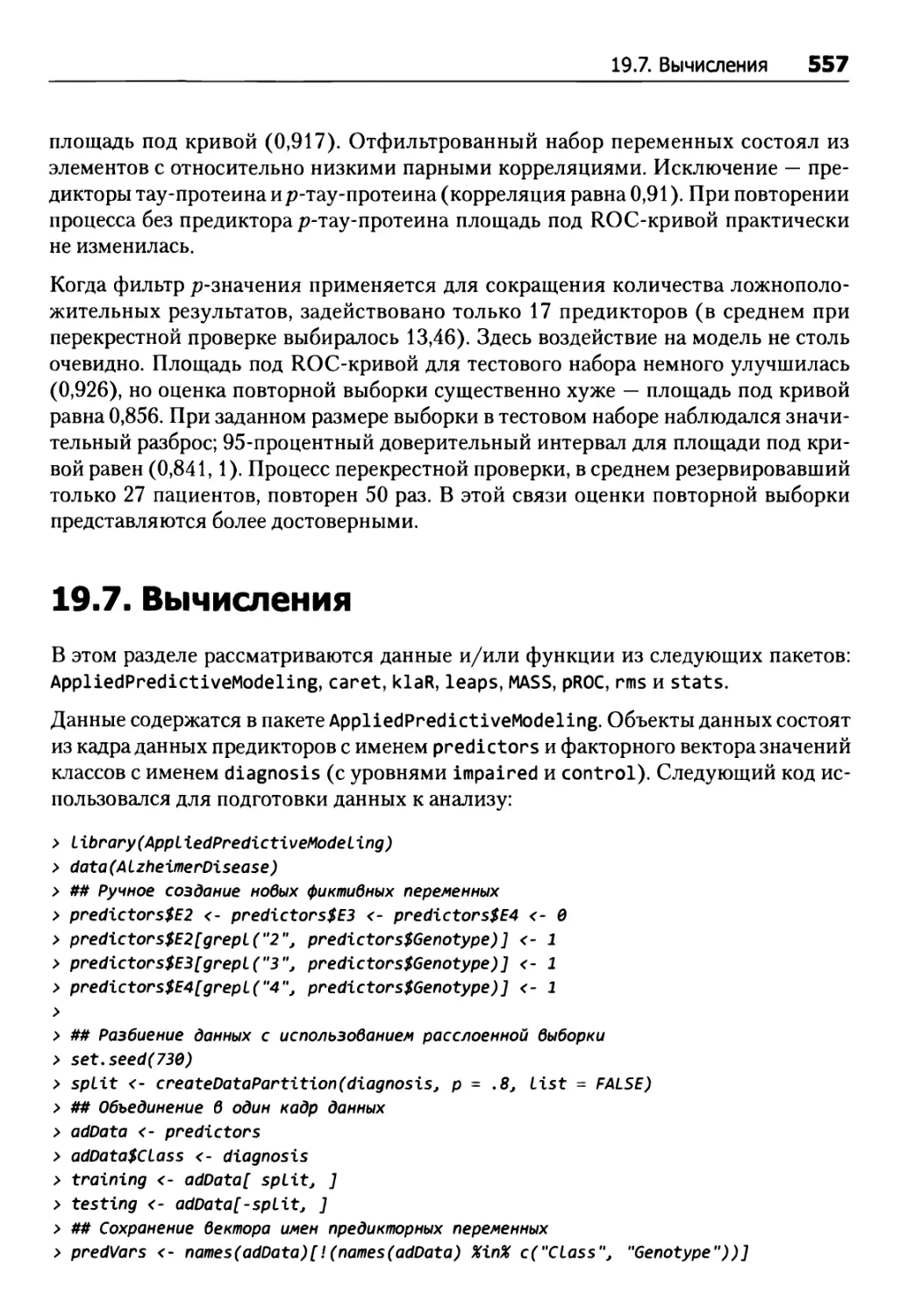

19.7. Вычисления 557

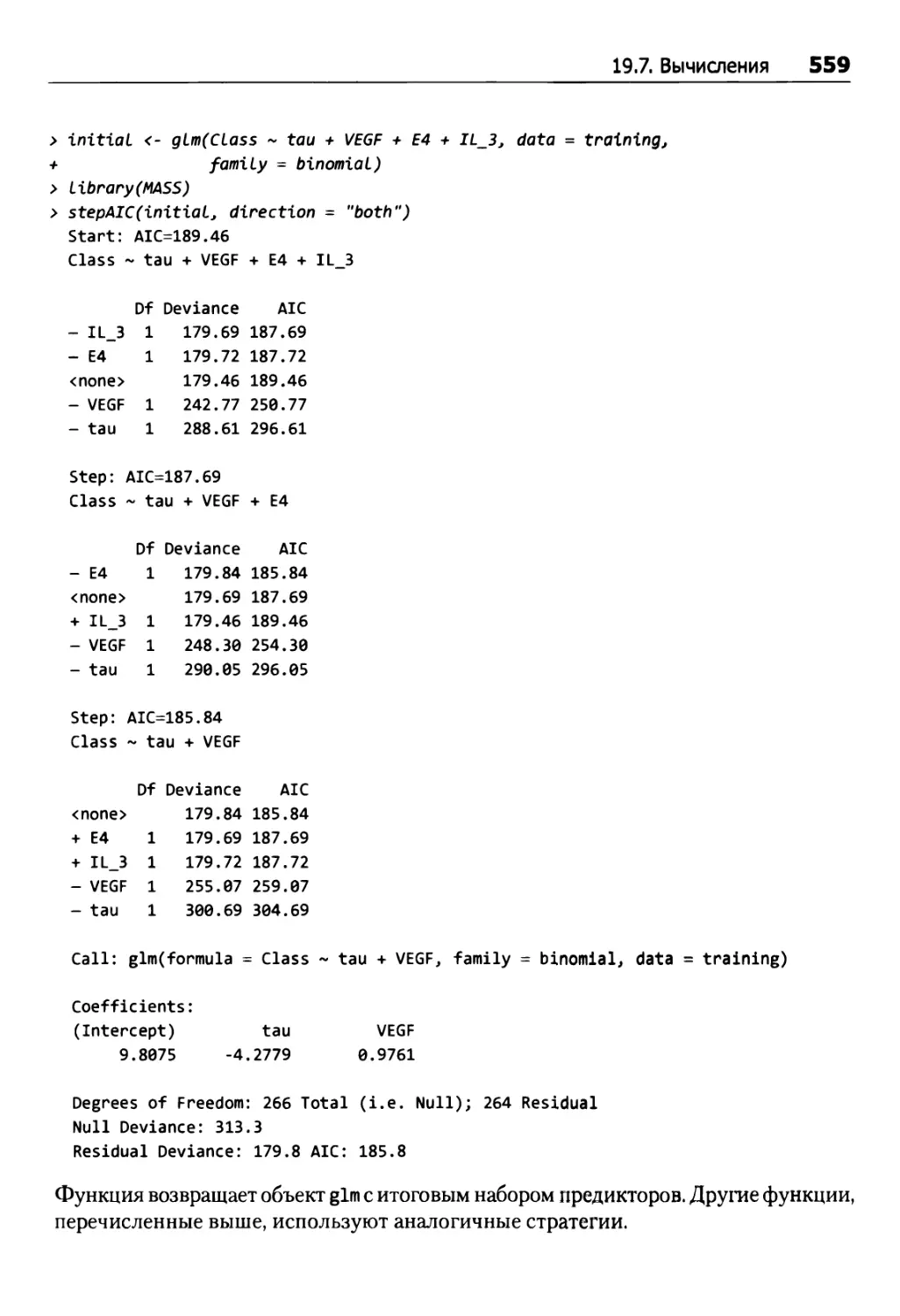

Прямой, обратный и пошаговый выбор 558

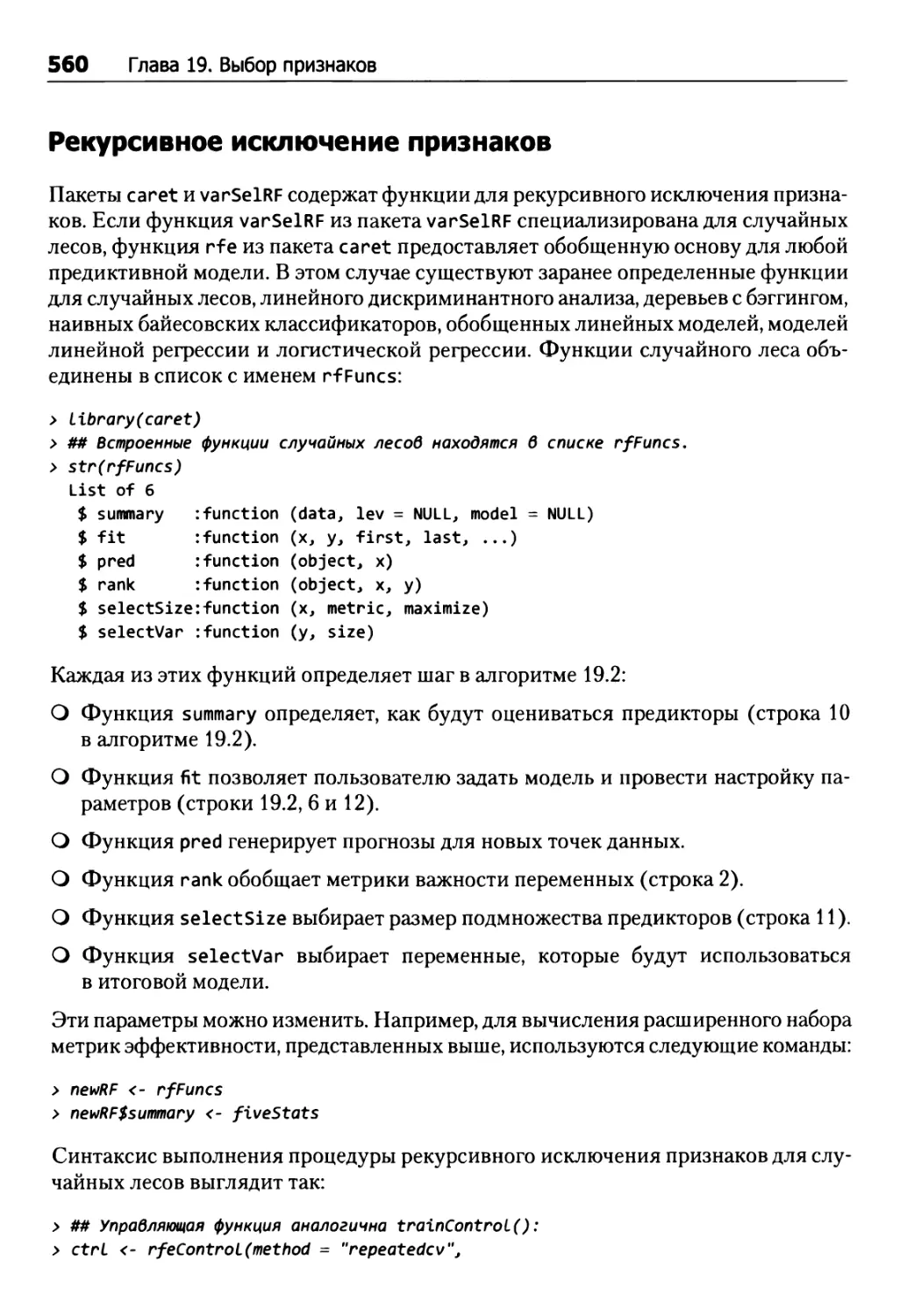

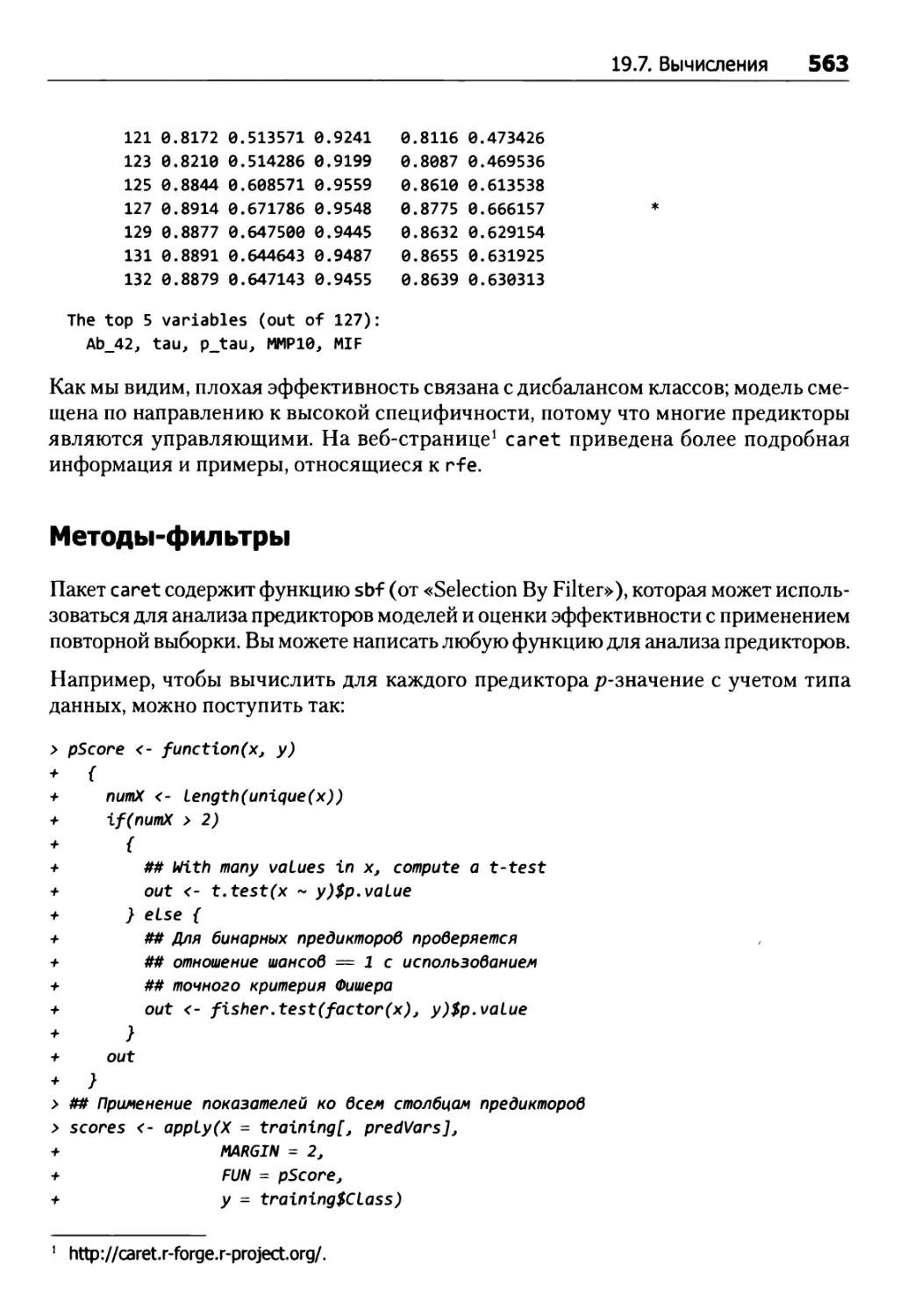

Рекурсивное исключение признаков 560

Методы-фильтры 563

Упражнения 565

Глава 20. Факторы, влияющие на эффективность модели 567

20.1. Ошибки III типа 568

20.2. Ошибка измерения результата 571

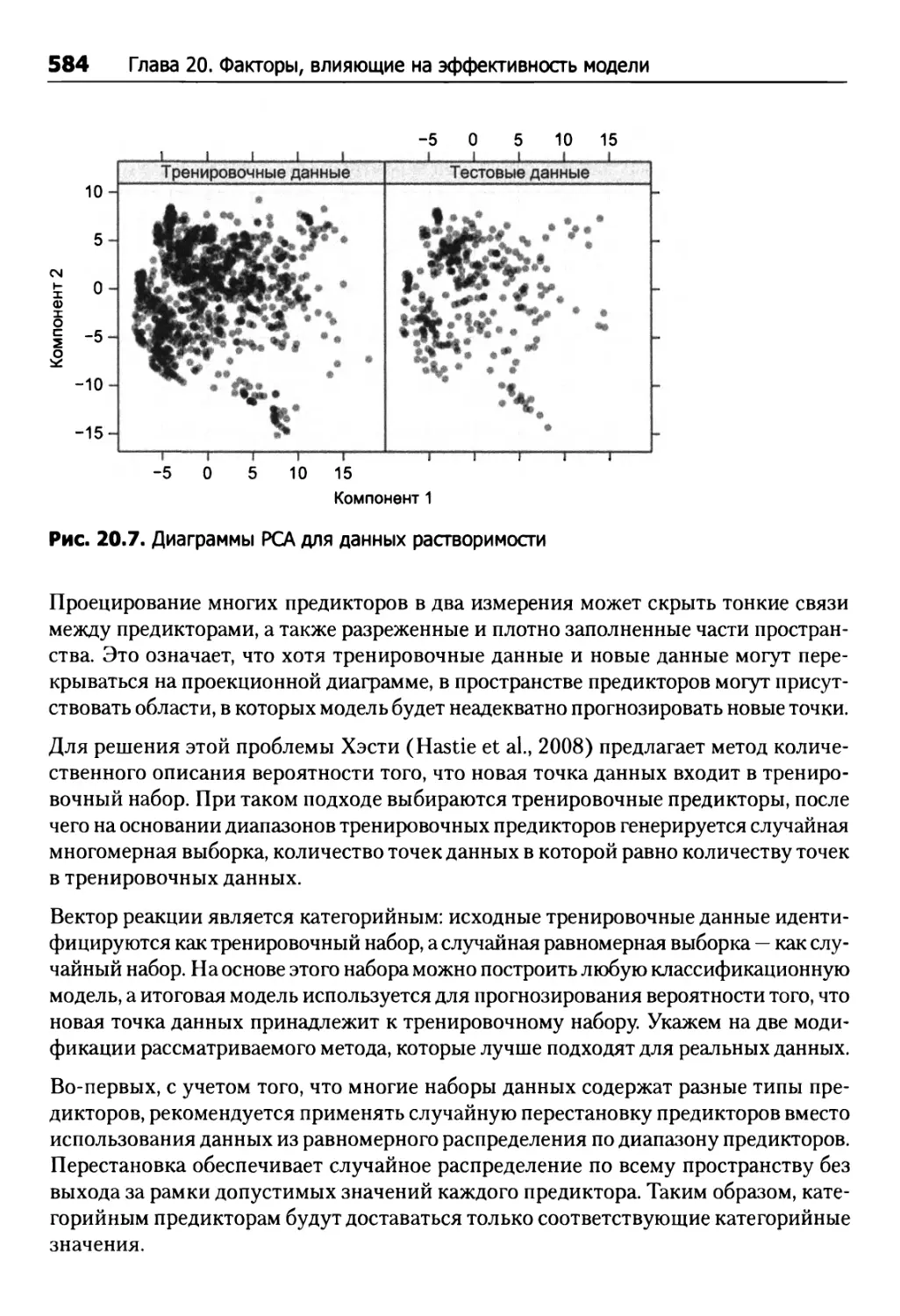

20.3. Погрешность измерений в предикторах 572

Практикум: прогнозирование нежелательных побочных эффектов 576

20.4. Дискретизация непрерывных результатов 578

20.5. Когда следует доверять прогнозу вашей модели? 582

20.6. Влияние большой выборки 586

20.7. Вычисления 588

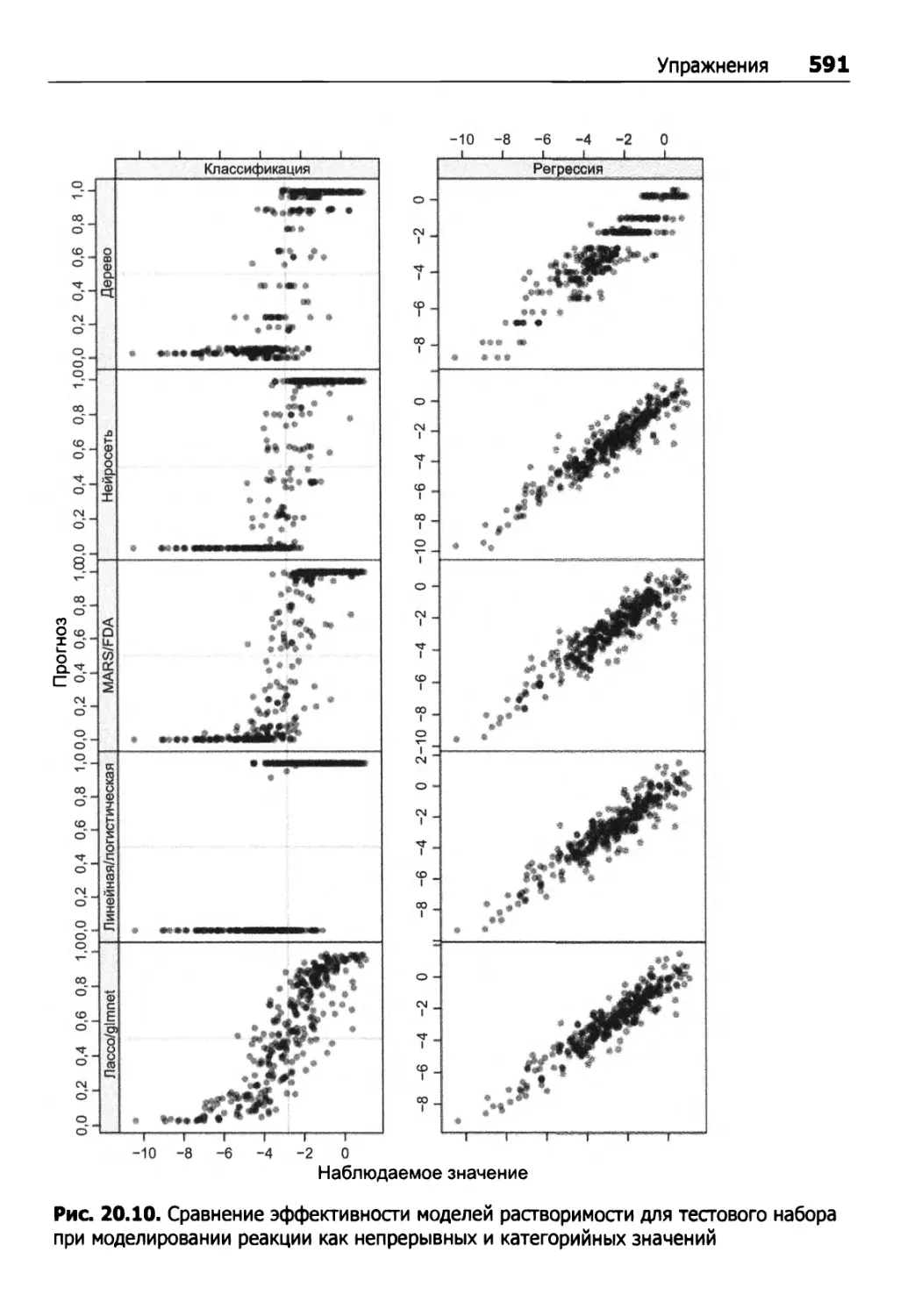

Упражнения 590

ПРИЛОЖЕНИЯ

Приложение А. Краткая сводка различных моделей 596

Приложение Б. Введение в R 599

Б.1. Запуск и вывод справочной информации 599

Б.2. Пакеты 600

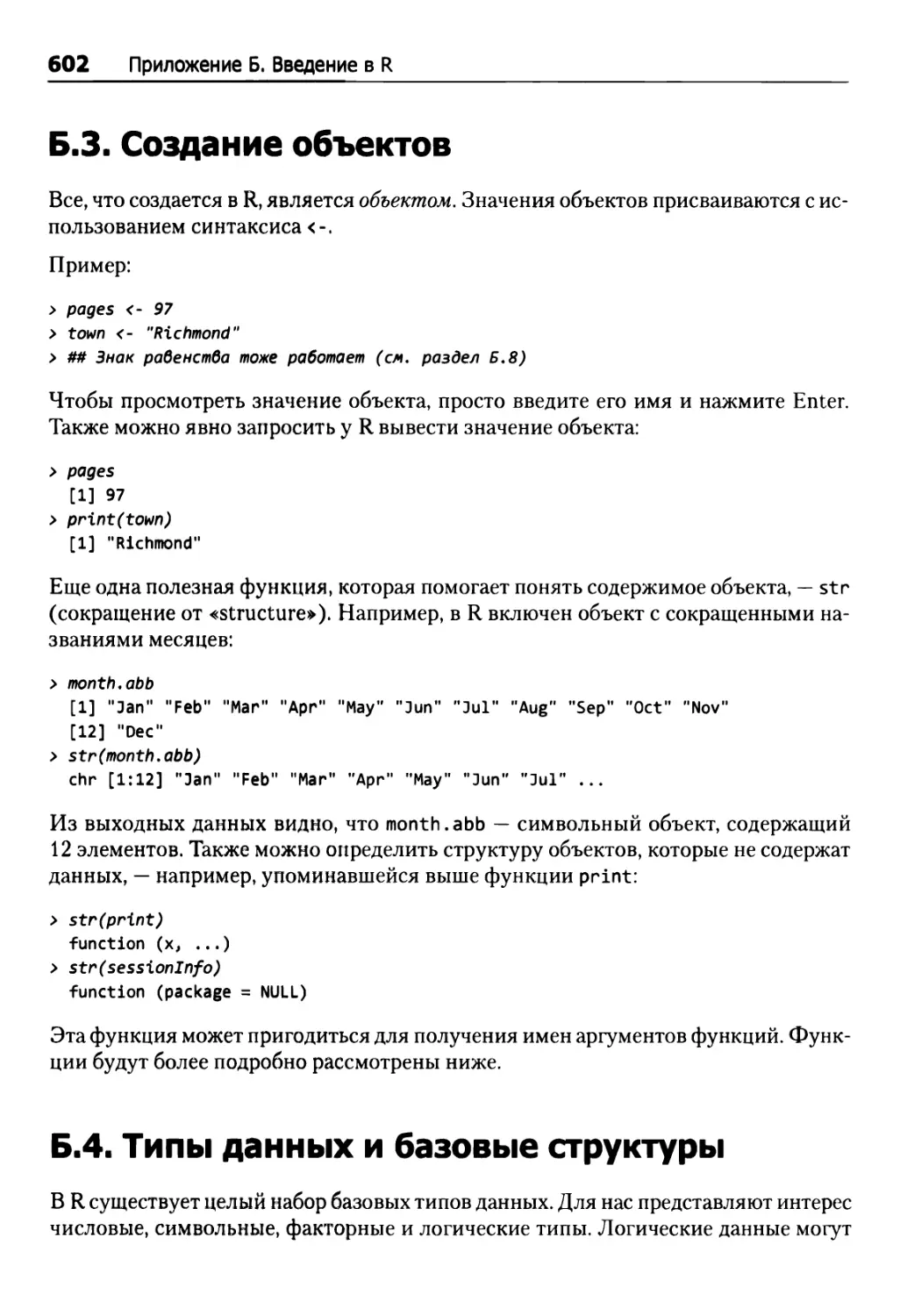

Б.З. Создание объектов 602

Б.4. Типы данных и базовые структуры 602

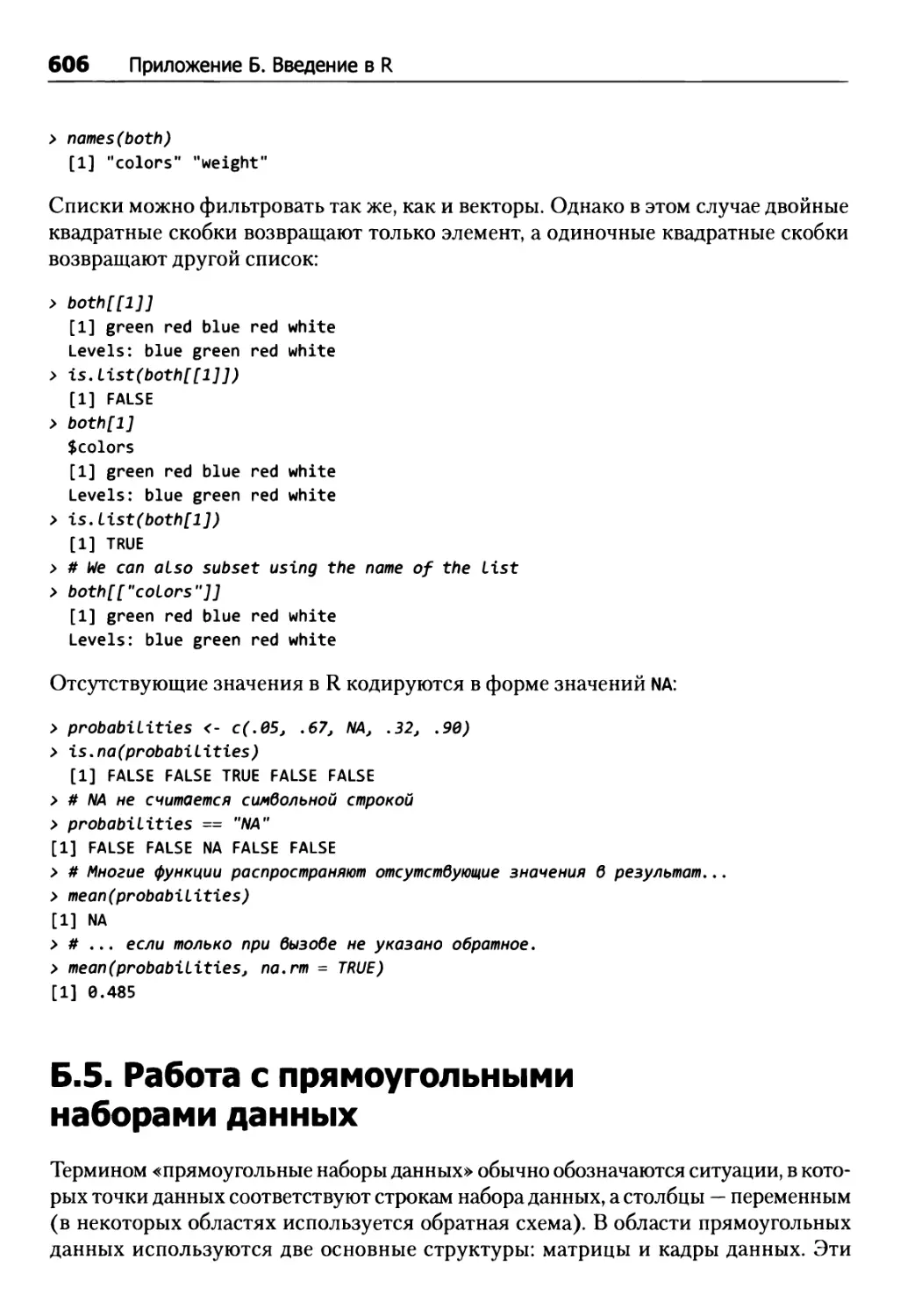

Б.5. Работа с прямоугольными наборами данных 606

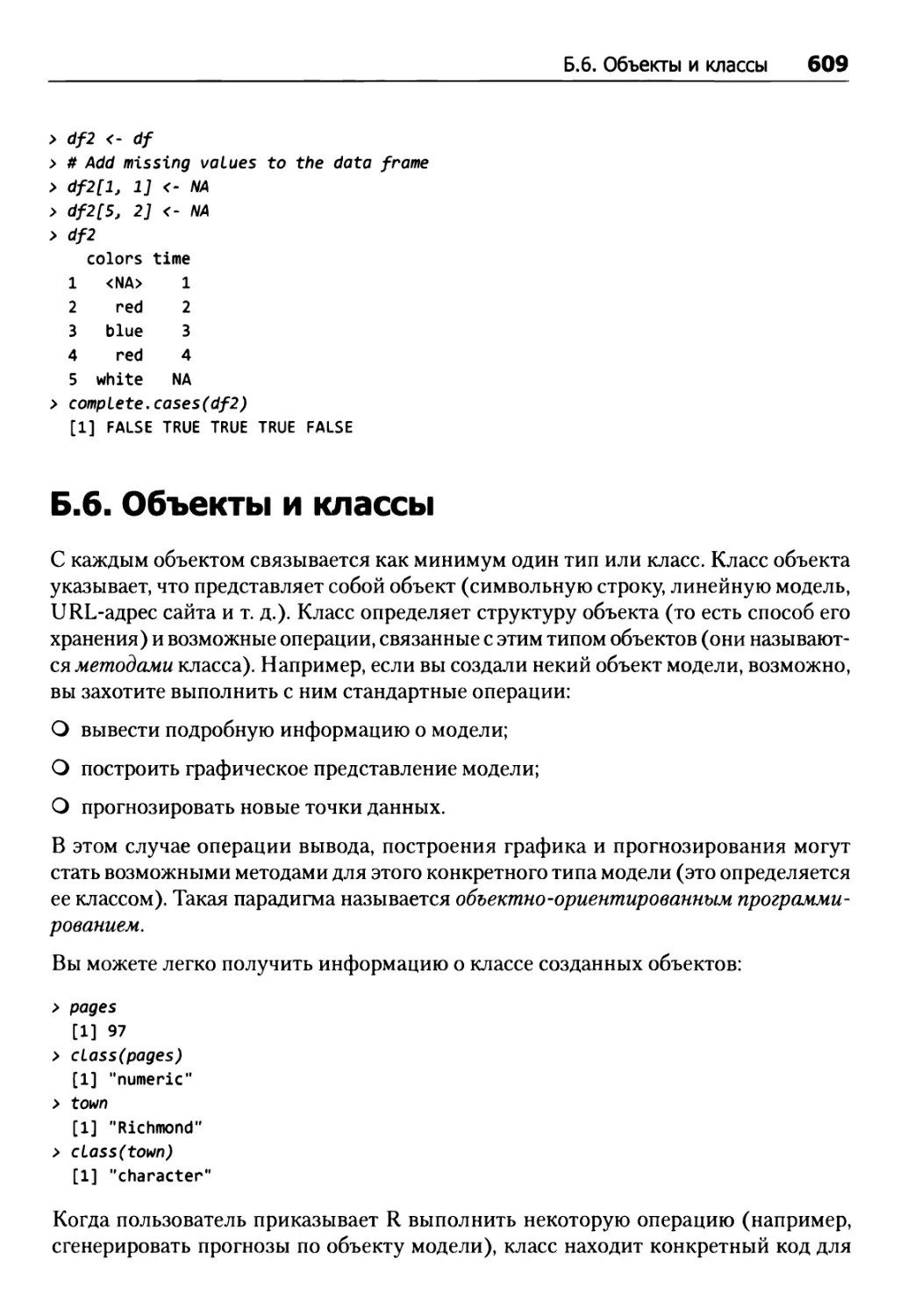

Б.6. Объекты и классы 609

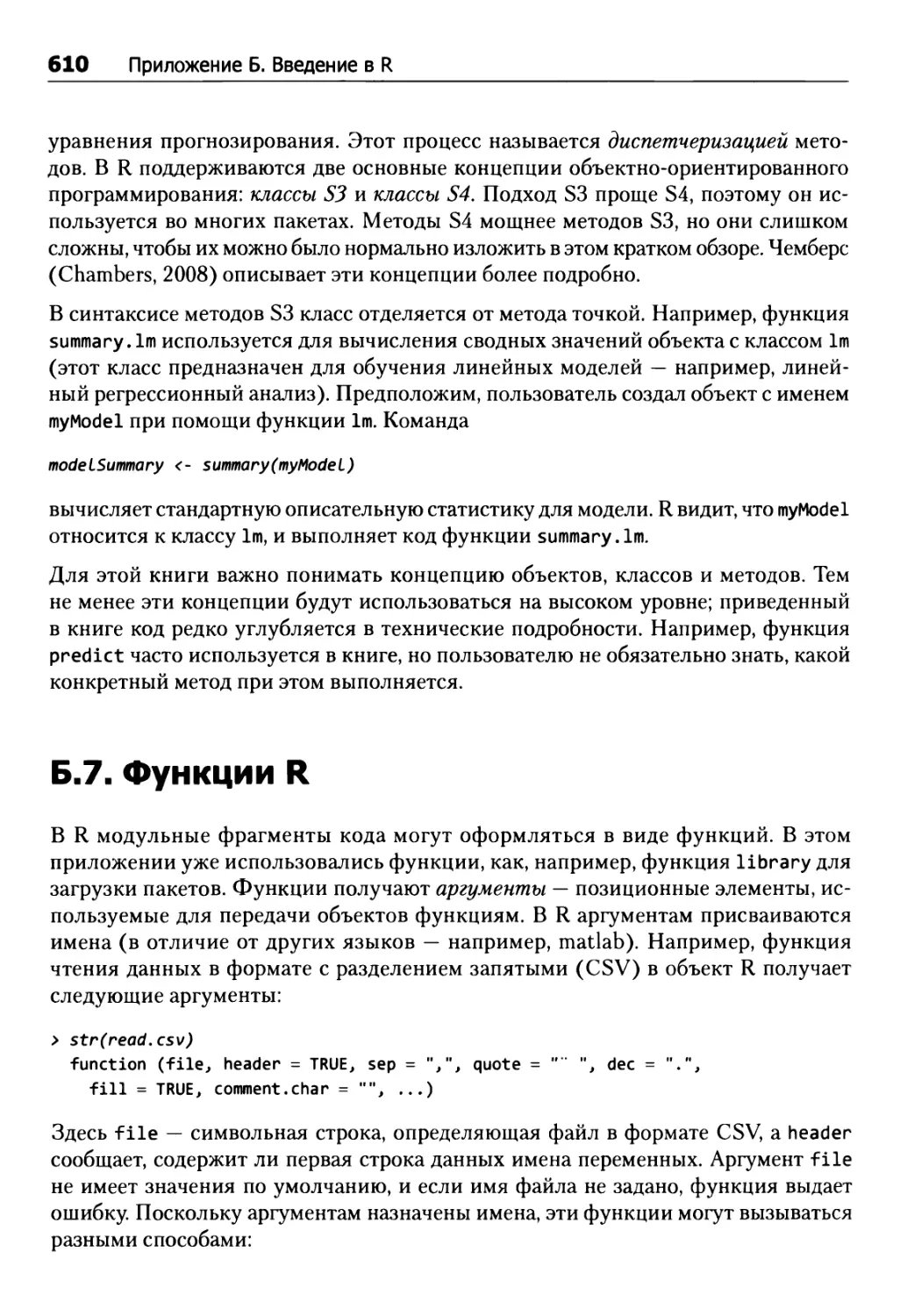

Б.7. Функции R 610

Б.8. Три грани = 611

Б.9. Пакет AppliedPredictiveModeling 611

Б.10. Пакет caret 612

Б.11. Пакеты, используемые в книге 615

Приложение В. Рекомендуемые веб-сайты 616

Слисок источников 619

Посвящается нашим семьям:

Миранде и Стефану

Валери, Трумэну и малышу Гидеону

Предисловие

Эта книга посвящена анализу данных, при этом особое внимание в ней уделяется практике предиктивного моделирования (predictive modeling). Термин «предиктивное моделирование» может вызвать ассоциации с такими темами, как машинное обучение, распознавание образов и глубокий анализ данных (data mining.) Действительно, эти ассоциации уместны, а методы, которые обычно связываются с этими терминами, являются неотъемлемой частью процесса предиктивного моделирования. Однако предиктивное моделирование отнюдь не ограничивается инструментами и методами выявления закономерностей в данных. Практика предиктивного моделирования определяет такой процесс разработки модели, который бы позволил нам понять и дать численную оценку предиктивной точности модели для будущих, пока еще отсутствующих данных. Центральное место в книге занимает этот процесс в целом.

Мы стремились к тому, чтобы эта книга послужила руководством для специалиста-практика к процессу предиктивного моделирования, а также источником информации, в котором читатель мог бы узнать о методе и получить представление о многих распространенных современных мощных моделях. В книге рассматриваются некоторые статистические и математические методы, но практически в каждом случае мы старались описывать методы так, чтобы дать читателю представление об их сильных и слабых сторонах, а не об их происхождении и математическом обосновании. Почти везде мы избегаем сложных формул, хотя без нескольких неизбежных исключений не обошлось. Если вас больше интересует теоретический взгляд на предиктивное моделирование, мы рекомендуем книги Хэсти и др. (Hastie et al., 2008) и Бишопа (Bishop, 2006). Для понимания материала читатель должен быть знаком с основными понятиями статистики: дисперсия, корреляция, простая линейная регрессия и базовая проверка гипотез (p-значения и статистика критерия).

Процесс предиктивного моделирования по своей природе практичен. Однако в ходе наших исследований для этой работы мы узнали, что во многих статьях и публикациях читатель не может воспроизвести результаты, потому что данные отсутствуют в свободном доступе или программное обеспечение недоступно либо доступно только на коммерческой основе. У Бакхайта и Донохо (1995) приведена уместная критика этой традиционной «дымовой завесы», свойственной для научной среды:

Предисловие 19

«Статья о вычислительных методах в научном издании — не сами научные знания, а всего лишь реклама научных знаний. Настоящие научные знания — это полная среда разработки и полный набор инструкций, на основе которых были построены графики».

Следовательно, мы стремились по возможности излагать материал на практическом уровне, чтобы читатель мог воспроизводить результаты с разумной точностью, а также естественным образом расширять метод предиктивного моделирования для своих данных. Кроме того, мы используем язык R (Ihaka and Gentleman, 1996; R Development Core Team 2010) — бесплатно распространяемый программный продукт для статистических и математических вычислений — на всех стадиях процесса предиктивного моделирования. Почти все наборы данных из примеров доступны в виде пакетов R. Пакет R AppliedPredictiveModeling содержит многие наборы данных и сценарии R, использованные в книге, для воспроизведения анализа в каждой главе.

Мы выбрали R в качестве вычислительного ядра этого текста по нескольким причинам. Во-первых, R распространяется бесплатно (хотя существуют и коммерческие версии) для нескольких операционных систем. Во-вторых, R публикуется на условиях стандартной общественной лицензии GPL (Free Software Foundation, июнь 2007 года), определяющей возможности повторного распространения программы. В этой структуре любой желающий может свободно анализировать и изменять исходный код. Благодаря модели распространения с открытым кодом уже существуют десятки предиктивных моделей, реализованных в виде бесплатных пакетов. Кроме того, R содержит мощную и обширную поддержку общего процесса предиктивного моделирования. Читатель, не знакомый с R, легко найдет в интернете множество учебников. Вводный курс R и руководство для начинающих приведены в приложении.

Некоторые темы нам не удалось рассмотреть из-за нехватки времени и/или места, и прежде всего обобщенные аддитивные модели, ансамбли разных моделей, сетевые модели, модели временных рядов и еще несколько.

У книги также существует веб-сайт:

http://appliedpredictivemodeling.com/

На нем будет публиковаться обновленная информация.

Эта книга появилась на свет только благодаря поддержке и наставлениям многих людей: Уолтера Г. Картера (Walter Н. Carter), Джима Гарретта (Jim Garrett), Криса Дженнингса (Chris Gennings), Пола Хармса (Paul Harms), Криса Кифера (Chris Keefer), Уильяма Клингера (William Klinger), Дайдзина Ко (Daijin Ко), Рича Мура (Rich Moore), Дэвида Нохаузера (David Neuhouser), Дэвида Поттера (David Potter), Дэвида Пайна (David Рупе), Уильяма Рэйенса (William Rayens), Арнольда Стромберга (Arnold Stromberg) и Томаса Видмара (Thomas Vidmar). Мы также хотим поблагодарить Росса Кинлана (Ross Quinlan) за помощь с Cubist и С5.0 и за

20 Предисловие проверку наших описаний этих двух тем. В издательстве Springer нам хотелось бы поблагодарить Марка Стросса (Mark Strauss) и Ханну Брэкен (Hannah Bracken), а также научных редакторов: Вини Бонато (Vini Bonato), Томаса Миллера (Thomas Miller), Росса Кинлана (Ross Quinlan), Эрика Сигела (Eric Siegel), Стэна Янга (Stan Young). Наконец, мы благодарим за поддержку свои семьи: Миранду Кун (Miranda Kuhn), Стефана Куна (Stefan Kuhn), Бобби Куна (Bobby Kuhn), Роберта Куна (Robert Kuhn), Карен Кун (Karen Kuhn) и Мэри Энн Кун (Mary Ann Kuhn); Уоррена (Warren) и Кей Джонсон (Kay Johnson); Валери (Valerie) и Трумэна Джонсона (Truman Johnson).

Гротон, штат Коннектикут, США, Макс Кун Сейлайн, штат Мичиган, США, Кьелл Джонсон

От издательства

Некоторые иллюстрации для лучшего понимания нужно смотреть в цветном варианте. Мы снабдили их QR-кодами, перейдя по которым вы можете ознакомиться с цветной версией рисунка.

Ваши замечания, предложения, вопросы отправляйте по адресу comp@piter.com (издательство «Питер», компьютерная редакция).

Мы будем рады узнать ваше мнение!

На веб-сайте издательства www.piter.com вы найдете подробную информацию о наших книгах.

Введение

Люди ежедневно сталкиваются с вопросами вроде: «По какому маршруту мне сегодня ехать на работу?», «Не переключиться ли мне на другого оператора сотовой связи?», «Как мне лучше вложить свои деньги?» или «Заболею ли я раком?». Эти вопросы свидетельствуют о нашем желании узнать, что произойдет в будущем, и мы непрестанно стараемся принять наилучшие решения на пути к этому будущему.

Обычно решения принимаются на основании информации. Иногда доступны реальные, объективные данные — например, информация об утренних пробках или метеосводки. В других случаях мы руководствуемся интуицией и опытом: «Мне лучше не ехать по мосту этим утром, потому что с началом снегопада здесь обычно возникают пробки» или «Мне стоит пройти анализ ПСА1, потому что у моего отца был рак простаты». В любом случае мы прогнозируем будущие события на основании уже имеющейся информации и опыта, а на основании этих прогнозов принимаются решения.

По мере того как с появлением интернета и социальных сетей информация стала более доступной, возросло и наше желание пользоваться этой информацией для принятия решений. И хотя человеческий мозг может сознательно и подсознательно накапливать огромные объемы данных, он не способен обработать еще больший объем доступной информации, относящейся к текущей задаче. Чтобы упростить процессы принятия решений, мы пользуемся такими инструментами, как Google, для фильтрации миллиардов веб-страниц и поиска самой релевантной информации для наших запросов, WebMD (для диагностики заболеваний по симптомам) и E*TRADE (для просеивания тысяч акций и нахождения лучших капиталовложений для наших портфелей).

Эти сайты наряду со многими другими используют инструменты, которые на основе текущей информации фильтруют данные в поисках закономерностей, относящих-

1 Простатический специфический антиген. — Примеч. пер.

22 Глава 1. Введение ся к сформулированной задаче, и возвращают ответы. Процесс разработки таких инструментов развивался в нескольких областях — химии, информатике, физике и статистике — и сегодня известен как «машинное обучение», «искусственный интеллект», «распознавание образов», «глубокий анализ данных», «предиктивная аналитика» и «извлечение информации». Хотя каждой области присуще решение свойственных ей задач с разных позиций и с использованием разных инструментов, конечная цель остается неизменной: создание точного прогноза. В этой книге мы объединим все эти термины в широко используемом выражении ^предиктивное моделирование».

Напомним, Гейссер (Geisser, 1993) определяет предиктивное моделирование как «процесс, используемый для создания или выбора модели в попытках наилучшим образом предсказать вероятность исхода». Мы слегка подправим это определение:

Предиктивное моделирование — это процесс разработки математического инструментария или модели, на основании которой генерируется точный прогноз.

В свою очередь, Стив Леви (Steve Levy) писал в журнале Wired о нарастающем присутствии предиктивных моделей (Levy, 2010) следующее: «Примеры [искусственного интеллекта] встречаются повсюду: глобальная машина Google использует искусственный интеллект для интерпретации невразумительных человеческих запросов. Компании — эмитенты кредитных карт — для выявления мошенничества. Netflix — для того, чтобы рекомендовать фильмы подписчикам. А финансовая система использует его для обработки миллиардов торговых операций (с относительно редкими обвалами)». Вот примеры вопросов, для получения ответов на которые нам хотелось бы использовать прогнозирование:

О Сколько экземпляров этой книги разойдется на рынке?

О Перенесет ли этот клиент свой бизнес в другую компанию?

О За сколько я смогу продать свое жилье при текущем состоянии рынка?

О Имеется ли у этого пациента конкретное заболевание?

О Какие фильмы заинтересуют зрителя, если руководствоваться его прошлыми решениями?

О Стоит ли мне продавать эти акции?

О Каких людей стоит свести друг с другом в нашем интернет-сервисе знакомств?

О Является ли это сообщение электронной почты спамом?

О Отреагирует ли пациент на некоторый вид терапии?

Теперь — пример иного рода. Как известно, страховые компании должны прогнозировать риски потенциальных страхователей автомобилей, здоровья и жизни.

Введение 23

Эта информация затем используется для определения того, стоит ли предоставить клиенту страховой полис, а если стоит, то с какой страховой премией.

Правительства, как и страховые компании, тоже стараются прогнозировать риски, но с целью защиты своих граждан. Из последних примеров правительственных предиктивных моделей можно привести биометрические модели выявления потенциальных террористов, модели выявления мошенничества (Westphal, 2008), модели беспорядков и бунтов (Shachtman, 2011). Даже посещение гастронома или бензоколонки (повседневных мест, в которых собирается и анализируется наша информация о покупках, в попытках определения того, кто мы и что нам нужно (Duhigg, 2012)) приводит нас в мир предиктивного моделирования, причем часто мы даже не подозреваем об этом. Как видим, предиктивные модели стали неотъемлемой частью нашего существования.

Хотя предиктивные модели помогают создавать продукты, отвечающие запросам потребителей, более качественные лекарства и делать более выгодные инвестиции, они регулярно порождают и неточные прогнозы, и неправильные ответы. Например, многие из нас не получали порой важные сообщения электронной почты из-за того, что предиктивная модель (фильтр электронной почты) неправильно распознала их как спам. Точно так же, впрочем, медицинские диагностические модели ставят ошибочные диагнозы, а финансовые предиктивные модели (финансовые алгоритмы) ошибочно покупают и продают акции в расчете на прибыли, которые в реальности оборачиваются потерями. Подобная ошибка предиктивной модели дорого обошлась многим инвесторам в 2010 году. Специалисты, следящие за состоянием фондовой биржи, наверняка помнят «молниеносный обвал» 6 мая 2010 года, когда рынок стремительно потерял более 600 пунктов, а затем немедленно отыграл их обратно. Через несколько месяцев исследований Комиссия по срочной биржевой торговле и Государственная комиссия по ценным бумагам и фондовому рынку определили, что причиной обвала стала ошибка алгоритмической модели (U.S. Commodity Futures Trading Commission and U.S. Securities & Exchange Commission. 2010).

По поводу «молниеносного обвала» и других подобных финтов предиктивных моделей Родригес (Rodriguez, 2011), в частности, пишет: «Предиктивное моделирование, как процесс создания или выбора модели в попытках наилучшим образом предсказать вероятность исхода, утратило доверие как инструмент прогнозирования». Он выдвигает гипотезу, согласно которой предиктивные модели регулярно сбоят, поскольку не учитывают такие сложные переменные, как человеческое поведение. В самом деле, наши возможности по прогнозированию или принятию решений ограничиваются нашими текущими и прошлыми знаниями, а также факторами, которые мы не учитываем. Эти реалии становятся ограничивающими факторами для любой предиктивной модели, однако они не должны препятствовать совершенствованию процесса их функционирования и улучшению самих моделей.

24 Глава 1. Введение

Отказы предиктивных моделей объясняются целым рядом типичных причин, которые будут описаны в последующих главах. Вот наиболее распространенные причины.

1. Недостаточная предварительная обработка данных.

2. Недостаточная проверка модели.

3. Неоправданная экстраполяция (например, применение модели к данным в пространстве, неизвестном для модели).

4. Переобучение модели к существующим данным.

Более того, замечено, что специалисты по предиктивному моделированию часто исследуют относительно небольшое количество моделей при поиске предиктивных связей. Чаще всего это объясняется личными предпочтениями, знаниями или опытом разработчика модели в использовании нескольких моделей либо отсутствием необходимого программного обеспечения, которое бы позволило проанализировать более широкий диапазон средств.

В этой книге мы попытались помочь разработчикам предиктивных моделей в построении надежных достоверных моделей. Для этого мы предоставили пошаговое описание процесса построения модели и общие сведения о широком спектре распространенных моделей. В книге также изложены:

О основополагающие принципы построения предиктивных моделей;

О доступные объяснения многих методов предиктивного моделирования, чаще иных применяемых для решения классификационных и регрессионных задач;

О принципы и этапы проверки предиктивной модели;

О компьютерный код для выполнения важнейших операций по построению и проверке предиктивных моделей.

Для демонстрации этих принципов и методов авторами использован широкий спектр реальных примеров из самых разных областей — от финансов до фармацевтики (они будут подробно описаны в разделе 1.4). Однако прежде следует проанализировать фактор, препятствующий применению методов предиктивного моделирования: компромисс между прогнозированием и интерпретацией.

1.1. Прогнозирование и интерпретация

Во всех перечисленных выше примерах обычно присутствуют исторические данные, пригодные для создания математических средств прогнозирования будущих непредвиденных случаев. Более того, конечная цель примеров не сводится лишь к пониманию того, почему что-то произойдет (или не произойдет). Нас прежде всего интересует точное определение вероятности того, что некое событие произойдет

1.2. Ключевые ингредиенты предиктивных моделей 25

или, напротив, не произойдет. Помните, что моделирование этого типа прежде всего направлено на оптимизацию точности прогнозов.

Например, нас не интересует, почему фильтр электронной почты считает, что сообщение является спамом. Важно лишь то, чтобы фильтр безошибочно искоренял спам и пропускал в электронный почтовый ящик только те сообщения, которые представляют для нас интерес.

Другой пример: если я продаю дом, то меня интересует не то, по каким критериям веб-сайт (скажем, zillow.com) сформирует его оценку, — важно лишь то, чтобы эта цена была определена правильно. Заниженная оценка означает снижение ставок и более низкую цену продажи, завышенная — отпугнет потенциальных покупателей. Противоречия между прогнозированием и интерпретацией наглядно проявляются и в области медицины. Представьте процесс, с которым сталкиваются врач и пациент при принятии решений об изменении терапии. Пациент и врач должны учитывать такие факторы, как режим дозирования, потенциальные побочные эффекты, уровень смертности. Но если достаточное количество пациентов прошло альтернативную терапию благополучно, то появляется возможность аккумулировать информацию, относящуюся к их заболеванию, истории лечения и демографии. Кроме того, можно провести лабораторные исследования по анамнезу пациента, некоторым другим данным (например, по выполненным ранее анализам уровня белка).

В результате становится возможным создать модель для прогнозирования реакции на альтернативную терапию. Критически значимым для врача и пациента является вопрос о том, как пациент отреагирует на смену терапии. Подобный прогноз должен быть максимально точным. Создаваемая для этого модель не должна ограничиваться требованием интерпретируемости (даже если кто-то сочтет это неэтичным). Ведь в конце концов, если модель может пройти соответствующую проверку, то неважно, будет это некий «черный ящик» или обычная интерпретируемая модель. Хотя главной задачей предиктивного моделирования должно быть генерирование точных прогнозов, его вторичной задачей может быть интерпретация модели и выработка понимания того, почему она работает. К сожалению, при стремлении к повышению точности модели становятся все более сложными, причем усложняется и их интерпретируемость. Как следствие, разработчикам моделей постоянно приходится отыскивать приемлемый компромисс между сложностью модели и точностью ее прогнозов.

1.2. Ключевые ингредиенты предиктивных моделей

Обиходные примеры, приводившиеся ранее, демонстрировали, что данные — более того, очень большие наборы данных — теперь могут легко генерироваться в попытке ответить на едва ли не любые вопросы исследователей, возникающие в ходе

26 Глава 1. Введение моделирования. Бесплатные или относительно недорогие программы построения моделей — JMP, НЕКА, многочисленные пакеты R, а также мощь современных персональных компьютеров позволяют любому человеку, мало-мальски разбирающемуся в компьютерных технологиях, без особого труда приступить к разработке предиктивных моделей. Но, как справедливо замечает тот же Родригес (Rodriguez, 2011), достоверность построения моделей снижается, особенно с расширением окна доступа к данным и аналитическим инструментам.

Как увидят далее наши читатели, если в наборе данных присутствует предиктивный сигнал, то он в той или иной степени будет обнаружен многими моделями независимо от метода или усилий, затраченных на их разработку. Таким образом, даже наивная модель может быть до известной степени эффективной; как гласит пословица, «раз в год даже палка стреляет».

Но самые лучшие, самые сильные предиктивные модели находятся под фундаментальным влиянием разработчика, обладающего экспертными знаниями, и контекста задачи, «под которую» создается модель. Сначала эти знания должны быть применены для получения релевантных данных, соответствующих целям исследования. Хотя огромные базы данных с информацией могут использоваться в качестве субстрата для построения прогнозов, не относящаяся к делу информация способна снизить предиктивную эффективность значительной части создаваемых моделей. Знания, относящиеся к конкретной теме, помогают отделить потенциально содержательную информацию от посторонней, снизив таким образом помехи и усилив скрытый сигнал.

В данных также могут присутствовать нежелательные искажающие сигналы, которые не могут быть выявлены без экспертных знаний. Ярким примером последнего служит база данных системы отчетов о нежелательных явлениях Управления США по надзору в сфере пищевых продуктов и лекарственных средств, включающая информацию о миллионах заявленных побочных эффектов от применения лекарств. В этом массиве данных присутствуют явные несуразности — например, поиск лекарства для лечения тошноты может показать, что значительная часть пациентов, использовавших это лекарство, болела лейкемией. Некомпетентный анализ может определить лейкемию как потенциальный побочный эффект от применения лекарства. Более вероятное объяснение, впрочем, заключается в том, что пациенты принимали лекарство от тошноты для подавления побочных эффектов терапии рака. Этот факт может быть очевиден интуитивно, но, несомненно, доступность огромного количества данных не защищает пользователей от издержек их использования, подобных описанным выше.

Эйрес (Ayres, 2007) в результате всестороннего изучения взаимодействий между экспертным мнением и эмпирическими моделями, управляемыми данными, делает два важных замечания, подчеркивающих необходимость знания специфики проблемы. Во-первых, пишет Эйрес, «в конечном итоге [предиктивное моделирование] не заменяет интуицию, а скорее дополняет ее».

1.3. Терминология 27

Говоря несколько иначе, ни модели, управляемые данными, ни эксперты, полагающиеся исключительно на интуицию, не обеспечат, действуя порознь, наилучшее решение задачи — необходимо объединение их усилий.

Во-вторых, указывает Эйрес, «традиционные эксперты принимают более качественные решения, когда они получают результаты статистического прогнозирования. Люди, цепляющиеся за авторитет традиционных экспертов, обычно склонны представлять идею объединения двух форм “знаний” при получении экспертом “статистической поддержки”. На самом деле люди обычно делают лучшие прогнозы, располагая для этого результатами статистического прогнозирования».

В некоторых случаях, например при обнаружении спама, можно поручить большую часть анализа компьютерам. Но при более серьезных потенциальных последствиях (например, при прогнозировании реакции пациента на лечение) комбинированный подход часто приводит к лучшим результатам.

Подведем итог: фундаментом эффективной предиктивной модели является интуиция и глубокое знание контекста проблемы. Именно эти факторы критически значимы для принятия решений относительно разработки модели. Процесс начинается с релевантных данных — еще один ключевой ингредиент. Третьим ингредиентом становится вариативный вычислительный инструментарий, включающий средства предварительной обработки и визуализации данных, а также набор средств моделирования для широкого спектра возможных сценариев; некоторые из этих сценариев перечислены в табл. 1.1.

1.3. Терминология

Как упоминалось ранее, «предиктивное моделирование» — всего лишь одно из обозначений процесса выявления связей в данных для прогнозирования некоторого желательного результата. Поскольку рассматриваемая нами область знаний лежит на стыке нескольких научных дисциплин, у многих понятий существуют синонимы.

О Так, термины точка данных (data point), выборка (sample), наблюдение (observation) или экземпляр (instance) обозначают независимую единицу данных, например клиента, пациента или вещество. Термин «выборка» также может обозначать подмножество точек данных — например, «выборка тренировочного набора» (training set sample). При использовании этого термина в дальнейшем нами будет уточняться контекст.

О Тренировочный набор (training set) состоит из данных, используемых для разработки моделей, тогда как термины тестовый набор (test set) или контрольный набор (validation set) используются исключительно для оценки эффективности итогового набора вариантов моделей.

28 Глава 1. Введение

Таблица 1.1. Сравнение некоторых характеристик наборов данных из примеров

Набор данных

производство химикатов

177

Непрерыв¬

ная

X

X

X

X

X

X

проницаемость

165

о

Непрерывная

X

X

X

X

мошенничество в финансовых отчетах

204

о см

Категорийная

X

X

X

X

поражение печени

281

с© |> со

Категорий¬

ная

X

X

X

X

X

X

X

заявки на предоставление грантов

8707

ОТ) хг см

Категорийная

X

X

X

X

X

X

музыкальный жанр

12 495

съ

Категорийная

X

X

X

X

X

Характеристика

Размеры

Точки данных

3 си о н X

5

4

6 е

Характеристики реакции

Категорийная или непрерывная

Сбалансированная / симметричная

Несбалансированная /скошен¬

ная

Независимая

Характеристики предикторов

Непрерывность

Счетность

Категорийность

Коррелированность

Разные шкалы измерений

Отсутствующие значения

Разреженность

1.4. Примеры наборов данных и типичные сценарии данных 29

О Предикторы (predictors), независимые переменные (independent variables), атрибуты (attributes) и дескрипторы (descriptors) — данные, используемые в качестве входных в формуле прогнозирования.

О Термины результат (outcome), зависимая переменная (dependent variable), цель (target), класс (class) млп реакция (response) обозначают итоговое прогнозируемое событие или величину

О Непрерывные (continuous) данные измеряются по естественной числовой шкале. Артериальное давление, стоимость товара, количество спален в доме — все это примеры непрерывных величин. В последнем случае значение не может быть дробным, но оно все равно относится к непрерывным данным.

О Категорийные данные (categorical data), также называемые качественными (nominal), или дискретными (discrete), принимают конкретные значения, не имеющие определенной шкалы. Примеры таких данных — кредитная история («хорошая» или «плохая») или цвет («красный», «синий» и т. д.).

О Термины построение модели (model building), обучение модели (model training) и оценка параметра (parameter estimation) обозначают процесс использования данных для определения значений в уравнениях модели.

1.4. Примеры наборов данных и типичные сценарии данных

В последующих главах для демонстрации методов будет использоваться анализ конкретных ситуаций. Но прежде, по-видимому, стоит кратко исследовать несколько примеров задач предиктивного моделирования и типы данных, используемых для их решения. Основное внимание будет уделяться разнообразию задач и характеристик собираемых данных. Некоторые наборы данных из примеров позаимствованы с конкурсов по машинному обучению, на которых ставятся реальные задачи с поощрением (часто денежным) за нахождение лучшего решения. Такие конкурсы уже давно проводятся в области предиктивного моделирования. Они оказали значительное воздействие на ее развитие.

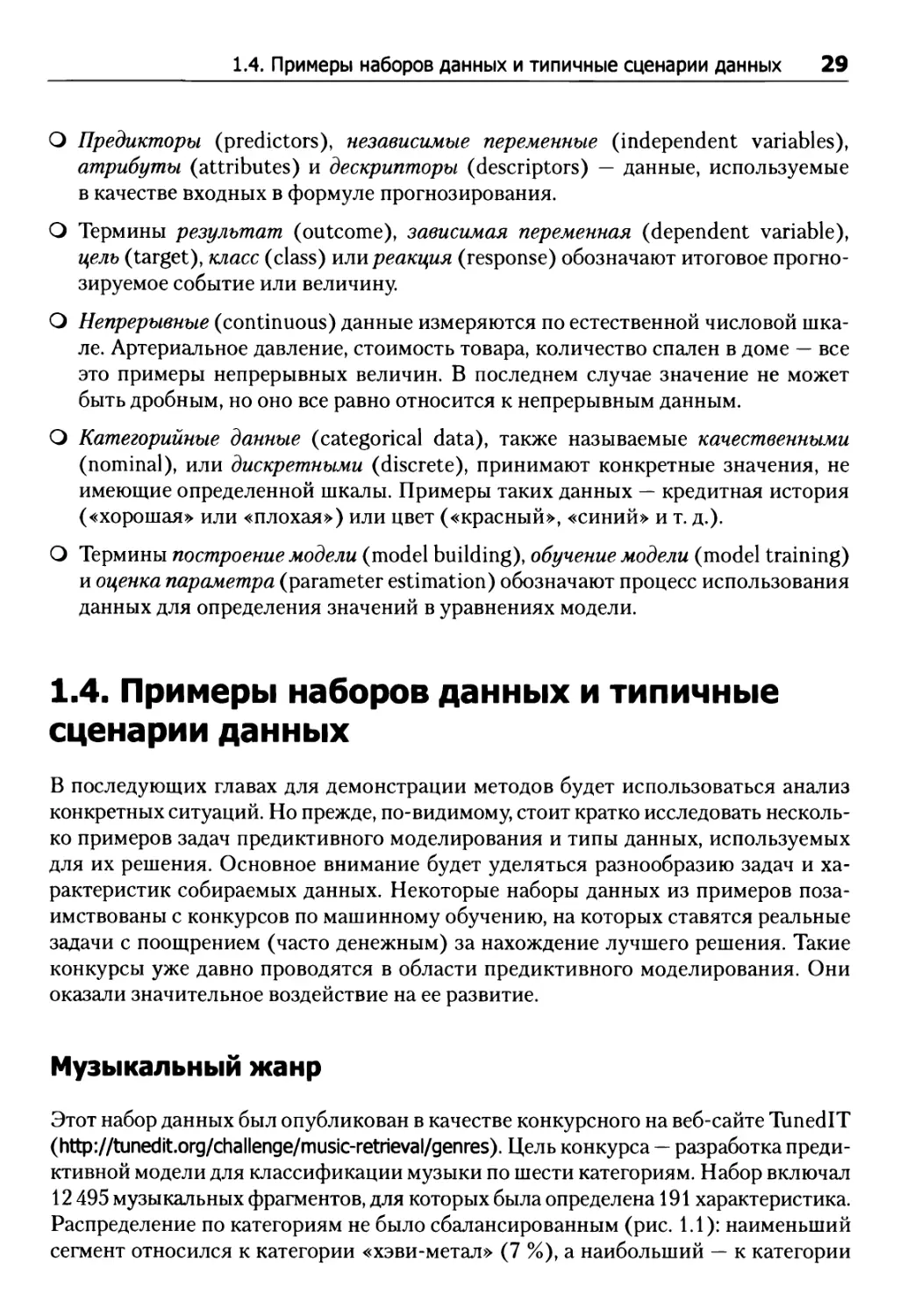

Музыкальный жанр

Этот набор данных был опубликован в качестве конкурсного на веб-сайте TunedIT (http://tunedit.org/challenge/music-retrieval/genres). Цель конкурса — разработка предиктивной модели для классификации музыки по шести категориям. Набор включал 12 495 музыкальных фрагментов, для которых была определена 191 характеристика. Распределение по категориям не было сбалансированным (рис. 1.1): наименьший сегмент относился к категории «хэви-метал» (7 %), а наибольший — к категории

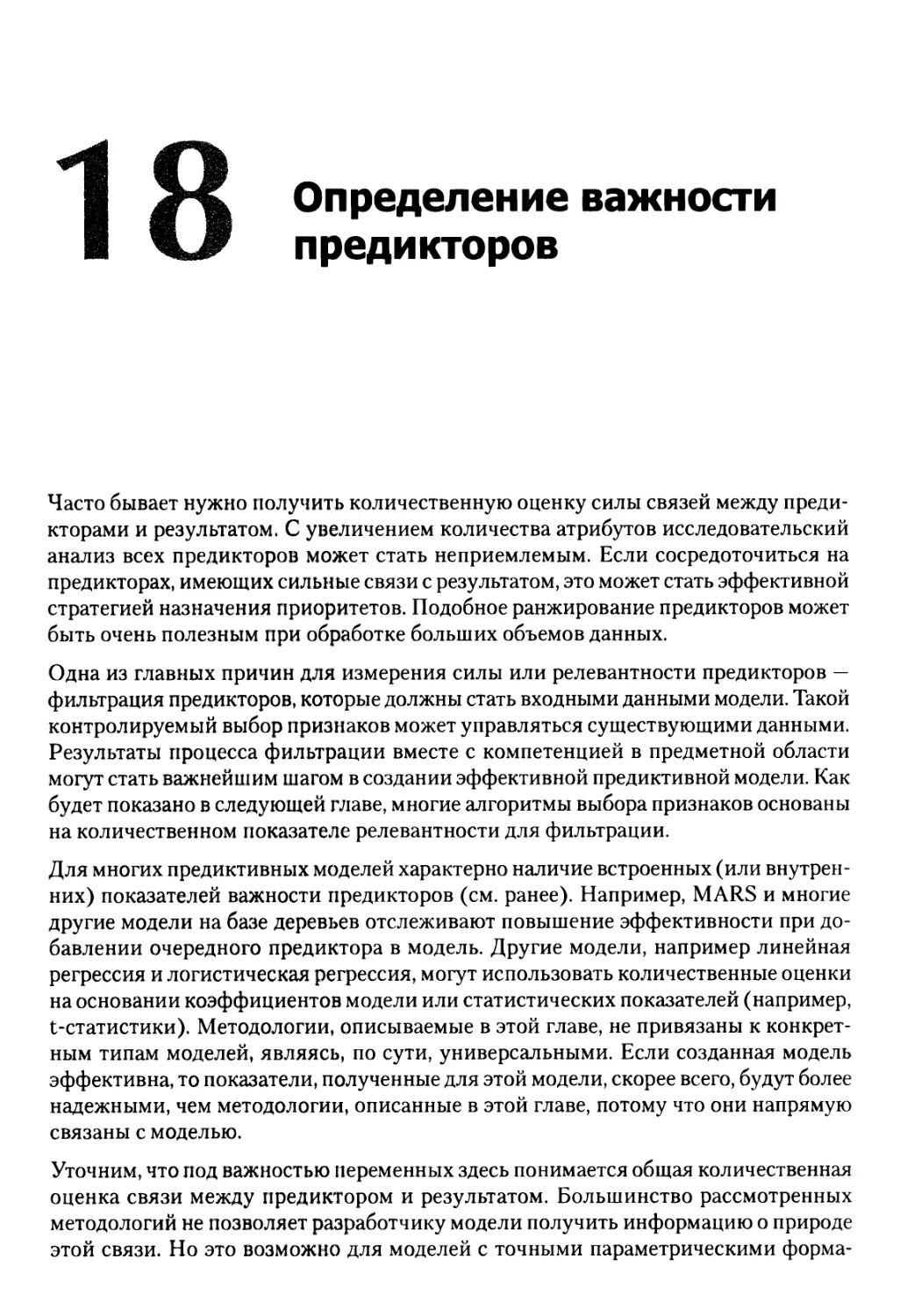

30 Глава 1. Введение «классика» (28 %). Все предикторы были непрерывными; многие из них обладали высокой корреляцией, охватывая несколько разных шкал измерения. Коллекция данных была создана на основе композиций 60 исполнителей (от 15 до 20 композиций для каждого). Затем 20 фрагментов каждой композиции были параметризованы для создания итогового набора данных. Следовательно, образцы по своей природе не являются независимыми друг от друга.

Рис. 1.1. Частотное распределение жанров в музыкальных данных

Заявки на получение грантов

Этот набор данных также был опубликован для конкурса — на веб-сайте Kaggle (http://www.kaggle.com). Цель конкурса — разработка предиктивной модели вероятности успеха заявки на получение гранта. База данных состояла из 8707 заявок на гранты, поданных в Университет Мельбурна с 2009 по 2010 год (количество предикторов — 249). Результат рассмотрения отражался в статусе заявки («успех» или «отказ»), из которых 46 % были квалифицированы как успешные. На веб-сайте упоминается, что текущий коэффициент успешности подобных заявок на гранты в Австралии составляет менее 25 %. Таким образом, показатели, присутствующие в базе данных, не являются типичными для Австралии. В числе предикторов — идентификатор спонсора, категория гранта, диапазон размеров гранта, область исследований и факультет. Все они являются непрерывными, счетными и категорийными. У этого набора данных есть и другая важная особенность: многие значения (83 %) предикторов отсутствовали. Кроме того, данные не были независимыми, так как одни и те же составители заявок фигурировали в них по несколько раз. Эти данные используются нами далее для демонстрации различных методов класси-

1.4. Примеры наборов данных и типичные сценарии данных 31

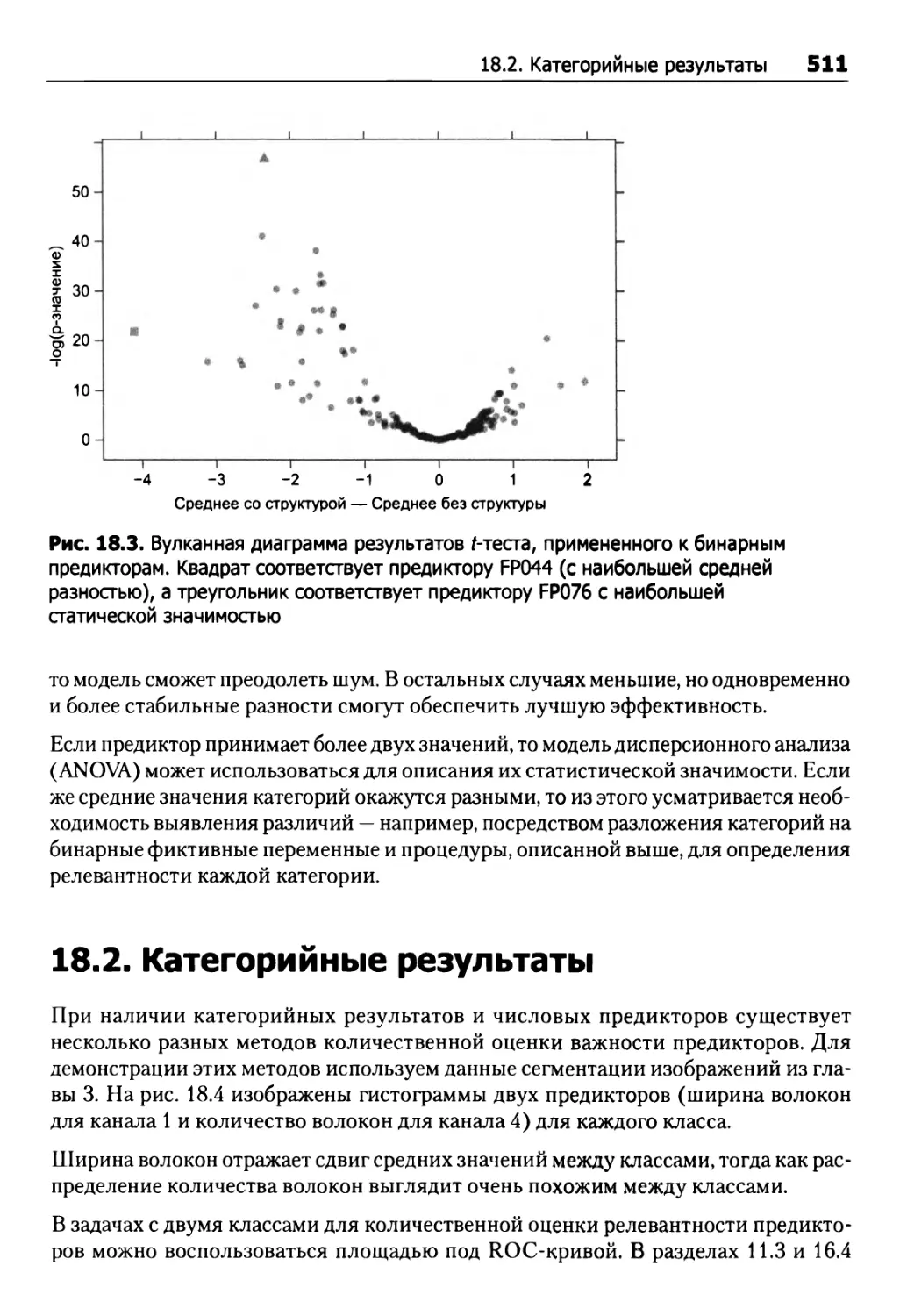

фикационного моделирования (см. главы 12-15, в том числе пояснение и сводку в подразделе 12.1).

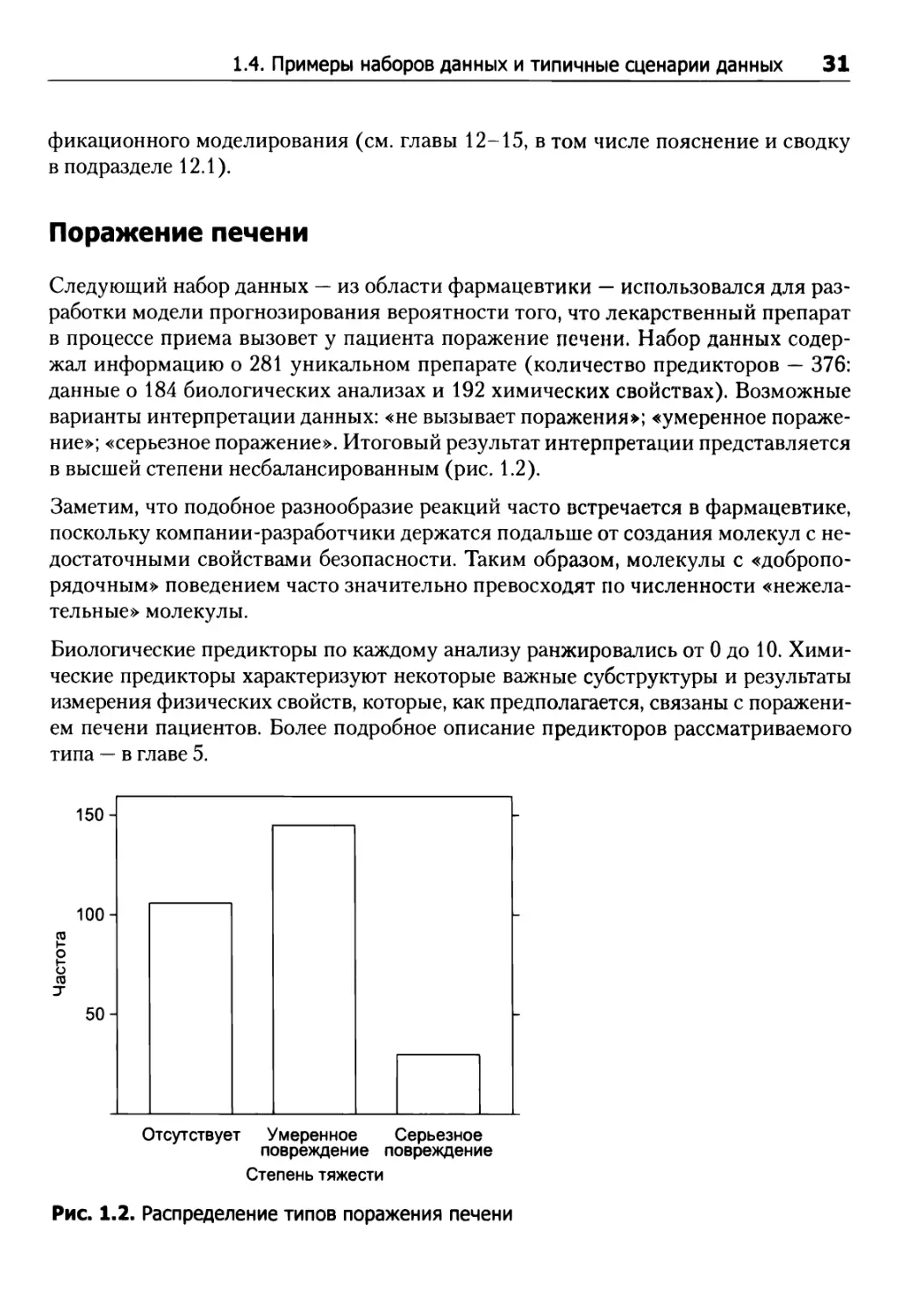

Поражение печени

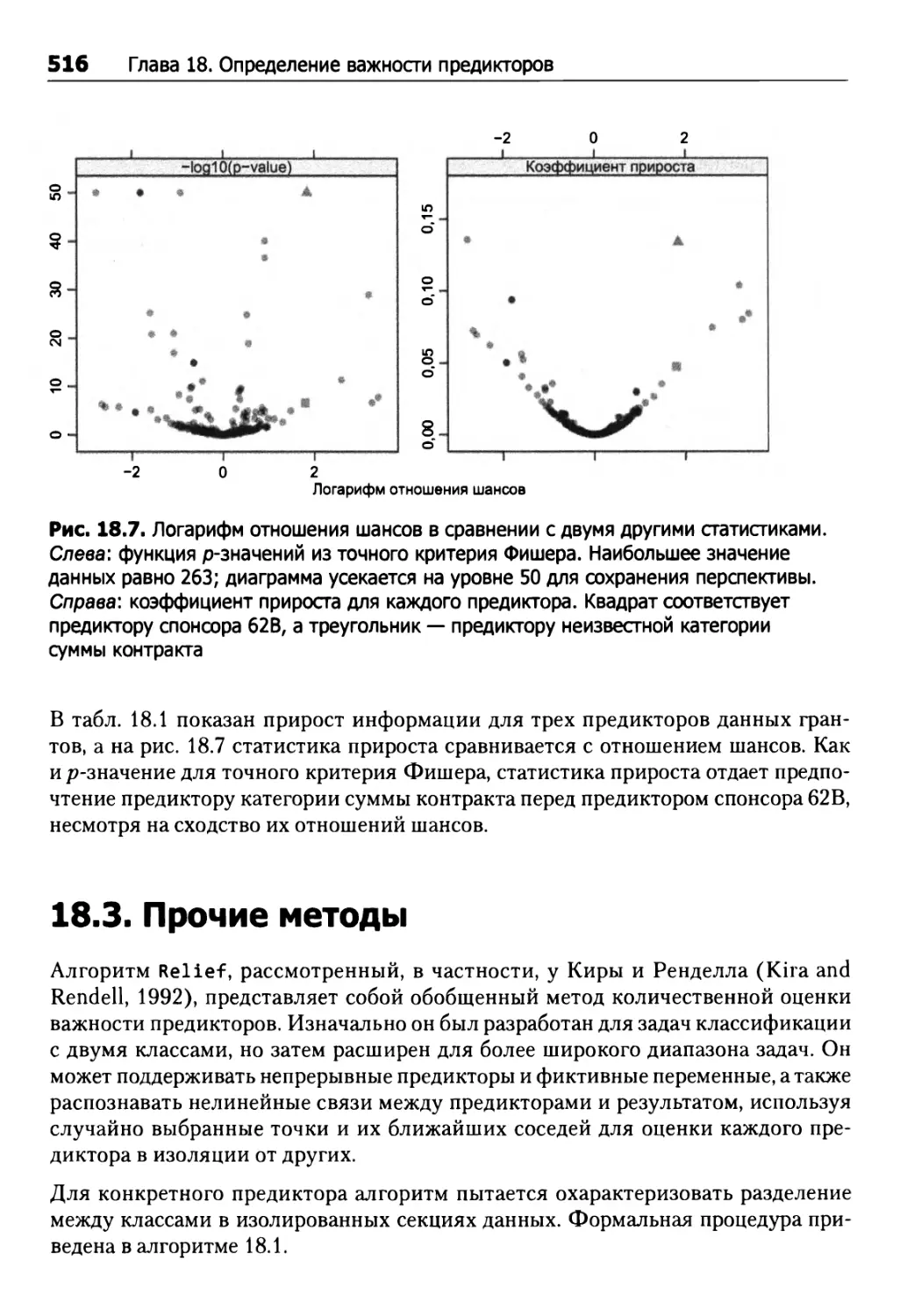

Следующий набор данных — из области фармацевтики — использовался для разработки модели прогнозирования вероятности того, что лекарственный препарат в процессе приема вызовет у пациента поражение печени. Набор данных содержал информацию о 281 уникальном препарате (количество предикторов — 376: данные о 184 биологических анализах и 192 химических свойствах). Возможные варианты интерпретации данных: «не вызывает поражения»; «умеренное поражение»; «серьезное поражение». Итоговый результат интерпретации представляется в высшей степени несбалансированным (рис. 1.2).

Заметим, что подобное разнообразие реакций часто встречается в фармацевтике, поскольку компании-разработчики держатся подальше от создания молекул с недостаточными свойствами безопасности. Таким образом, молекулы с «добропорядочным» поведением часто значительно превосходят по численности «нежелательные» молекулы.

Биологические предикторы по каждому анализу ранжировались от 0 до 10. Химические предикторы характеризуют некоторые важные субструктуры и результаты измерения физических свойств, которые, как предполагается, связаны с поражением печени пациентов. Более подробное описание предикторов рассматриваемого типа — в главе 5.

Рис. 1.2. Распределение типов поражения печени

32 Глава 1. Введение

Проницаемость

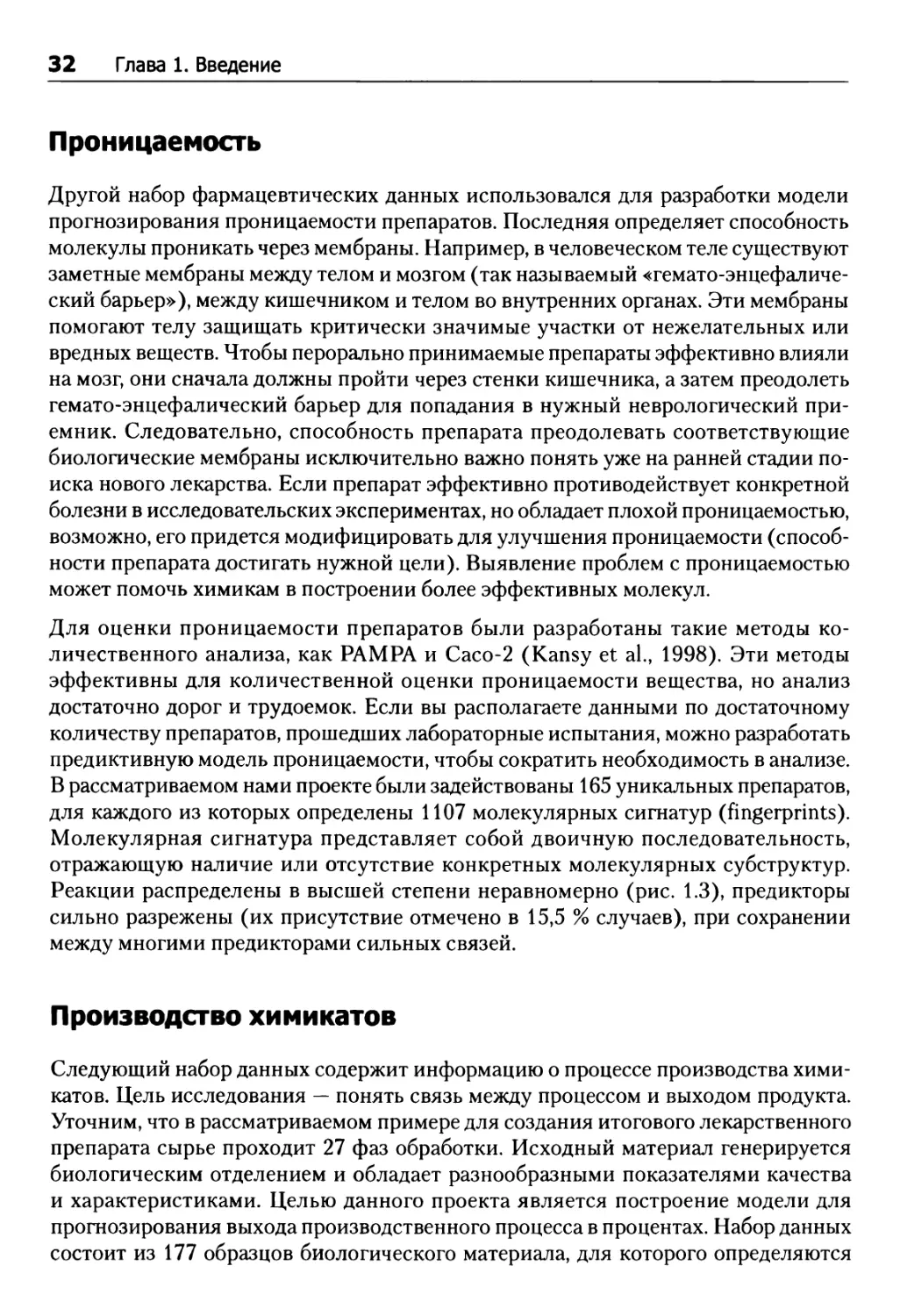

Другой набор фармацевтических данных использовался для разработки модели прогнозирования проницаемости препаратов. Последняя определяет способность молекулы проникать через мембраны. Например, в человеческом теле существуют заметные мембраны между телом и мозгом (так называемый «гемато-энцефалический барьер»), между кишечником и телом во внутренних органах. Эти мембраны помогают телу защищать критически значимые участки от нежелательных или вредных веществ. Чтобы перорально принимаемые препараты эффективно влияли на мозг, они сначала должны пройти через стенки кишечника, а затем преодолеть гемато-энцефалический барьер для попадания в нужный неврологический приемник. Следовательно, способность препарата преодолевать соответствующие биологические мембраны исключительно важно понять уже на ранней стадии поиска нового лекарства. Если препарат эффективно противодействует конкретной болезни в исследовательских экспериментах, но обладает плохой проницаемостью, возможно, его придется модифицировать для улучшения проницаемости (способности препарата достигать нужной цели). Выявление проблем с проницаемостью может помочь химикам в построении более эффективных молекул.

Для оценки проницаемости препаратов были разработаны такие методы количественного анализа, как PAMPA и Сасо-2 (Kansy et al., 1998). Эти методы эффективны для количественной оценки проницаемости вещества, но анализ достаточно дорог и трудоемок. Если вы располагаете данными по достаточному количеству препаратов, прошедших лабораторные испытания, можно разработать предиктивную модель проницаемости, чтобы сократить необходимость в анализе. В рассматриваемом нами проекте были задействованы 165 уникальных препаратов, для каждого из которых определены 1107 молекулярных сигнатур (fingerprints). Молекулярная сигнатура представляет собой двоичную последовательность, отражающую наличие или отсутствие конкретных молекулярных субструктур. Реакции распределены в высшей степени неравномерно (рис. 1.3), предикторы сильно разрежены (их присутствие отмечено в 15,5 % случаев), при сохранении между многими предикторами сильных связей.

Производство химикатов

Следующий набор данных содержит информацию о процессе производства химикатов. Цель исследования — понять связь между процессом и выходом продукта. Уточним, что в рассматриваемом примере для создания итогового лекарственного препарата сырье проходит 27 фаз обработки. Исходный материал генерируется биологическим отделением и обладает разнообразными показателями качества и характеристиками. Целью данного проекта является построение модели для прогнозирования выхода производственного процесса в процентах. Набор данных состоит из 177 образцов биологического материала, для которого определяются

1.4. Примеры наборов данных и типичные сценарии данных 33

Рис. 1.3. Распределение проницаемости

57 характеристик. Из этих 57 характеристик 12 относятся к исходному биологическому материалу, а 45 являются метриками производственного процесса. К переменным процесса относятся такие показатели, как температура, время просушки, время промывки и концентрации сопутствующих продуктов в разных фазах. Одни метрики процесса могут контролироваться, другие — только наблюдаются. Предикторы являются непрерывными, счетными и категорийными, между некоторыми из них существует корреляция, у отдельных отсутствует часть значений. Образцы не являются независимыми, так как наборы образцов берутся из одной партии исходного биологического материала.

Мошенничество в финансовых отчетах

Фэннинг и Коггер (Fanning and Cogger, 1998) описывают набор данных, ис- пользованный для прогнозирования случаев управленческого мошенничества в компаниях, зарегистрированных на бирже. Используя открытые источники данных, в частности документы Государственной комиссии по ценным бумагам и фондовому рынку, авторы смогли выявить 102 мошеннических финансовых отчета. Учитывая, что фальсификация встречается лишь в небольшом проценте отчетов, было решено собрать информацию об эквивалентном количестве1 добросовестных компаний; эта информация была использована для контроля важных факторов (например, размер компании, ее принадлежность к определенной отрасли). 150 точек данных использовались для тренировки моделей, остальные 54 — для оценки их эффективности.

1 Такой тип выборочных исследований очень близок к исследованиям методом «случай- контроль» в медицинской области.

34 Глава 1. Введение

Первоначально использовалось неопределенное количество предикторов, выявленных в результате анализа ключевых областей, таких как коэффициент текучести руководства, судебные разбирательства и структура долга. В итоге количество предикторов сократилось до 20. Примеры — отношение дебиторской задолженности к объему продаж, отношение складских запасов к объему продаж, изменение валовой прибыли по годам и др. Многие предиктивные переменные, содержащие различные отношения, используют общие знаменатели (например, отношение дебиторской задолженности к объему продаж и отношение складских запасов к объему продаж). Хотя фактические точки данных не были опубликованы, скорее всего, между предикторами существуют сильные корреляции.

С точки зрения моделирования этот пример интересен по нескольким причинам.

Во-первых, из-за значительного дисбаланса в классах частоты двух классов в наборах данных сильно отличались от прогнозируемой генеральной совокупности. Распространенная стратегия минимизации последствий подобных дисбалансов — так называемое прореживание (down-sampling) данных.

Во-вторых, количество возможных предикторов было существенно больше количества точек данных. В этом примере выбор предикторов для моделей был нетривиальной задачей из-за небольшого количества подходящих точек данных, в том числе для построения моделей и для оценки их эффективности. В дальнейших главах будет рассмотрена проблема переобучения, при которой тенденции в тренировочных данных не встречаются в других выборках. При большом количестве предикторов и малом количестве точек данных появляется риск того, что релевантный предиктор, обнаруженный в этом наборе данных, не будет воспроизводиться в других наборах.

Сравнения наборов данных

Дальнейшие примеры демонстрируют характеристики, общие для большинства наборов данных. Прежде всего, реакция может быть непрерывной или категорийной, а для категорийных реакций могут быть задействованы две и более категории. Для данных непрерывной реакции распределение реакции может быть симметричным (например, производство химикатов) или асимметричным (например, проницаемость); для данных категорийных реакций распределение может быть сбалансированным (например, заявки на предоставление грантов) или несбалансированным (например, музыкальный жанр, поражение печени).

В главе 4 наши читатели увидят, что понимание распределения реакции критично для одного из первых шагов процесса предиктивного моделирования — разбиения данных на тренировочные и тестовые наборы. Понимание распределения реакции поможет разработчику модели в поиске лучших способов разбиения данных; непонимание характеристик реакции может создать вычислительные сложности для

1.4. Примеры наборов данных и типичные сценарии данных 35

некоторых видов моделей и моделей, обладающих субоптимальной предиктивной способностью.

Наборы данных, описанные в табл. 1.1, также подчеркивают характеристики предикторов, универсальные для большинства наборов данных. Так, значения предикторов могут быть непрерывными, счетными и/или категорийными, в них может отсутствовать часть значений, могут использоваться разные шкалы измерения предикторов, и др. Кроме того, предикторы в наборе данных могут иметь высокую корреляцию — признак того, что набор предикторов содержит избыточную в числовом отношении информацию.

Также предикторы могут быть разреженными', это означает, что большинство точек данных содержит одну и ту же информацию, и только некоторые из них — уникальную информацию. Как и реакции, предикторы могут иметь симметричное или смещенное распределение (для непрерывных предикторов), быть сбалансированными или несбалансированными (для категорийных предикторов). Наконец, предикторы в пределах набора данных могут иметь скрытые связи с реакцией или не иметь их. Разные виды моделей по-разному решают проблемы с подобными характеристиками. Например, метод частных наименьших квадратов естественным образом решает проблемы с корреляцией предикторов, но в числовом отношении он работает стабильнее, если предикторы измеряются по сходным шкалам. С другой стороны, на рекурсивное секционирование различия в шкалах не влияют, при этом структура секционирования становится менее стабильной при наличии корреляции между предикторами. Другой пример: множественная линейная регрессия не справляется с отсутствием информации предикторов, но рекурсивное секционирование может применяться в том случае, если предикторы содержат умеренное количество отсутствующей информации. В любой из этих ситуаций отсутствие необходимой регулировки предикторов до моделирования — предварительной обработки (pre-processing) — создает модели с субоптимальной эффективностью прогнозирования. Оценка характеристик предикторов и их регулировка посредством предварительной обработки рассматриваются в главе 3.

Наконец, каждый из этих наборов данных демонстрирует другую фундаментальную характеристику, которая должна учитываться при построении предиктивной модели: связь между количеством точек данных (я) и количеством предикторов (Р). В случае с набором данных музыкальных жанров количество точек данных (п - 12 496) намного превышает количество предикторов (Р= 191). Все предиктивные модели справляются с этой ситуацией, но время вычислений зависит от модели и, скорее всего, увеличится с ростом количества точек данных и предикторов. И наоборот, в наборе данных проницаемости количество точек данных (п = 165) намного меньше количества предикторов (Р= 1107). Соответственно, такие предиктивные модели, как множественная линейная регрессия или линейный дискриминантный анализ, не могут использоваться напрямую. Тем не

36 Глава 1. Введение менее некоторые модели (например, рекурсивное секционирование и метод k ближайших соседей (KNN)) можно применять напрямую и в описываемых условиях. При рассмотрении каждого метода в последующих главах мы будем указывать, насколько хорошо метод справляется с наборами данных при п < Р. Для тех методов, которые в этой ситуации не работают, будут предложены альтернативные методы моделирования или действия по предварительной обработке, фактически сокращающие размерность пространства предикторов.

Итак, до построения модели необходимо сформировать глубокое понимание предикторов и реакции на любой набор данных. Отсутствие такого понимания может привести к вычислительным сложностям и, как следствие, весьма условной эффективности модели. Кроме того, многие наборы данных потребуют известной предварительной обработки для расширения пространства возможных предиктивных моделей и оптимизации эффективности прогнозирования каждой модели.

1.5. Структура книги

Книга состоит из четырех частей, в которых будет представлен процесс построения и критической оценки предиктивных моделей. Так как многие читатели, скорее всего, захотят реализовать представленные концепции, в конце каждой главы имеется раздел с кодом реализации рассмотренных тем. В тексте будет использоваться язык программирования R (R Development Core Team 2010). Для читателей, не знакомых с языком R, в приложении Б приведен краткий вводный курс.

Цель приложения Б — ознакомить читателей с наиболее существенной информацией по основным программным конструкциям R. Тем не менее для читателей без опыта работы с R информации в приложении может оказаться недостаточно. В качестве дополнительного учебного материала мы можем порекомендовать следующие публикации: Verzani (2002); Venables et al. (2003); Maindonald and Braun (2007); Muenchen (2009); Spector (2008).

В части I объясняются методы закладки надежных фундаментов, на которых строятся модели. Прежде чем пытаться моделировать какие-либо данные, необходимо хорошо понять краеугольные концепции их предварительной обработки (глава 3) и повторной выборки (глава 4).

В главе 3 рассматриваются распространенные методы предварительной обработки: преобразование данных, добавление и/или удаление переменных, статистическая группировка непрерывных переменных. Здесь же подробно объясняется, почему для большинства моделей перед моделированием необходимо произвести предварительную обработку данных.

В главе 4 представлена суть расходования данных, а также методы их расходования для соответствующей настройки модели и оценки ее эффективности. Там же по-

1.5. Структура книги 37

меняется, что для решения любой конкретной задачи специалист-практик всегда должен опробовать разнообразные модели.

Заложив, таким образом, фундамент предиктивного моделирования, мы перейдем к обзору традиционных и современных регрессионных методов (часть II). Эта часть книги начинается с освещения способов оценки эффективности при моделировании непрерывного результата (глава 5).

В главе 6 представлено рабочее и интуитивное понимание регрессионных моделей, формирующих иерархически ниже следующую структуру данных в форме линейной комбинации предикторов. К этому классу моделей относятся линейная регрессия, метод частных наименьших квадратов и L1-регуляризация.

Далее (глава 7) дается объяснение регрессионных моделей, не основанных на простых линейных комбинациях предикторов. К этому классу, напомним, относятся нейросети, многомерные адаптивные регрессионные сплайны (MARS), метод опорных векторов (SVM) и KNN.

Древовидные модели также не ограничиваются линейными комбинациями предикторов. С учетом популярности и широты применения в ансамблевых методах древовидные модели рассматриваются в отдельной главе (глава 8), где представлен обзор регрессионных деревьев, случайных лесов, усиления и Cubist.

Часть II завершается анализом практического примера (глава 10), в котором сравниваются все вышеперечисленные методы применительно к конкретной задаче: моделированию прочности сжатия бетона для получения состава с улучшенными свойствами.

После регрессионных моделей в рамках части III рассматриваются предиктивные классификационные модели. Метрики производительности для задач классификации отличаются от метрик регрессионных задач (глава 11).

В главе 12 представлено рабочее и интуитивное понимание классификационных моделей, основанных на линейных комбинациях предикторов, таких как линейные, квадратичные, регуляризованные модели и дискриминантный анализ частных наименьших квадратов. Здесь же рассматриваются штрафные методы классификации.

В главе 13 исследуются методы классификации, основанные на в высшей степени нелинейных функциях предикторов. К этому классу относятся гибкий дискриминантный анализ, нейросети, SVM, KNN, наивная классификация Байеса и ближайшие центроиды. Древовидные методы классификации рассматриваются в главе 14. В главе 17 представлен практический пример классификации со сравнительным анализом методов.

В части IV рассматриваются другие важные соображения построения модели или оценки ее эффективности. В стремлении к поиску самых релевантных предикторов для имеющейся задачи было предложено множество различных типов методов выбора. Хотя эти методы обладают потенциалом обнаружения информации, со-

38 Глава 1. Введение держательной в практическом смысле, они часто помогают пользователю уяснить помехи в данных, а не их структуру.

В главе 18 продемонстрированы различные методы количественной оценки важности предикторов. В главе 19 представлено введение и руководство по правильному использованию методов выбора признаков. Заметим, что на эффективность модели могут влиять самые разные факторы, вводя, таким образом, в заблуждение практика и заставляя его поверить, что модель имеет плохую предиктивную эффективность (тогда как в действительности эффективность хорошая) или модель имеет хорошую предиктивную эффективность (хотя на деле все обстоит наоборот). Некоторые типичные факторы, влияющие на эффективность модели, — избыточные помехи в наборе предикторов, реакции и предиктивная экстраполяция рассматриваются в главе 20.

1.6. Условные обозначения

Среди прочих целей авторы книги стремились предоставить интуитивно понятные описания многих методов. Там, где это возможно, вместо формул используются слова. Многие модели могут быть выражены в алгоритмическом виде, но для некоторых из них предпочтительнее формулы. Обычно символы х и у с разными шрифтами и в разном регистре представляют предикторы и реакцию модели соответственно. В тексте они выглядят следующим образом:

О п = количество точек данных;

О Р = количество предикторов;

О yi - i-e наблюдаемое значение результата, г = 1 ... п;

О £ = прогнозируемый результат г-й точки данных, i = 1 ... п;

О у = выборочное среднее значение для п наблюдаемых значений результата;

О у = вектор всех п значений результата;

О х- = значение у-го предиктора для г-й точки данных, i = 1,..., п uj = 1 ..., Р;

О Xj = выборочное среднее значение п точек данных для/го предиктора, J = 1,

О х, = коллекция (то есть вектор) Р предикторов для г-й точки данных, г = 1,..., п;

О X = матрица Р предикторов для всех точек данных; матрица содержит п строк и Р столбцов;

О Xх = транспонированная матрица X; эта матрица содержит Р строк и п столбцов.

1,6. Условные обозначения 39

Другие условные обозначения, встречающиеся по ходу изложения в формулах:

О С = количество классов в категорийном результате;

О Се = значение уровня /*-го класса;

О р = вероятность события;

О = вероятность Лго события;

О Рг[.] = вероятность события;

п

О £ = оператор суммирования по индексу i;

i=l

О Z = теоретическая ковариационная матрица;

О £[•] = ожидаемое значение •;

О /(•) = функция .; для функций в тексте также используются обозначения g(-) и/г();

О р = неизвестный или теоретический коэффициент модели;

О Ь = оценочный коэффициент модели, полученный на основании выборки точек данных.

Для освещения отдельных тем и моделей авторами также используются другие обозначения (см. соответствующие пояснения по ходу изложения).

Часть I

ОБЩИЕ СТРАТЕГИИ

Краткий обзор процесса предиктивного моделирования

Прежде чем перейти к глубокому изучению формальных компонентов построения модели, рассмотрим простой пример, иллюстрирующий основы ее построения, точнее, то, что в дальнейшем будет именоваться как «расходование» данных, построение моделей-кандидатов и выбор оптимальной модели.

2.1. Пример прогнозирования экономии топлива

На веб-сайте fueleconomy.gov, принадлежащем Управлению по энергоэффективности и возобновляемым источникам энергии Министерства энергетики США и Агентству охраны окружающей среды США, перечислены различные оценки экономии топлива для легковых и грузовых автомобилей. Для каждого вида транспорта регистрируются различные характеристики, включая объем двигателя и число цилиндров. Параллельно проводятся лабораторные измерения потребления топлива в городе и на автострадах (в милях на галлон (MPG)).

На практике для нахождения наиболее эффективной предиктивной модели ее следовало строить с учетом максимально возможного числа характеристик. Тем не менее в данном примере нас интересуют прежде всего высокоуровневые концепции построения модели, поэтому мы ограничимся одним предиктором — объемом двигателя (пространством в цилиндрах двигателя) и одной реакцией — нескорректированным показателем MPG на автостраде для автомобилей 2010-2011 годов выпуска.

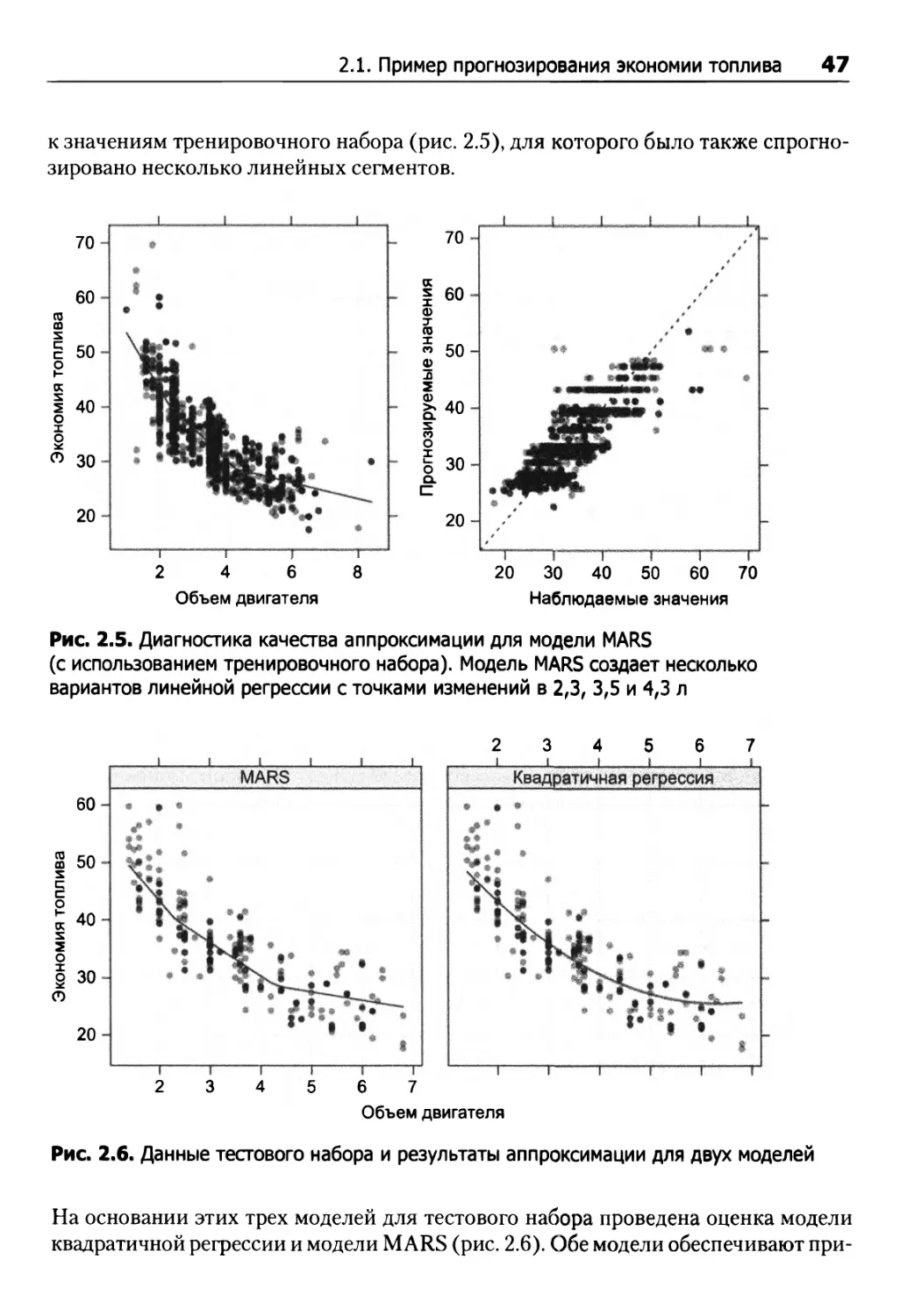

Построение модели начинается с уяснения исходных данных — допустим, посредством их представления в графическом виде. Поскольку в нашем примере используются один предиктор и одна реакция, эти данные могут быть представлены в виде графика (рис. 2.1), отражающего зависимость между объемом двигателя и экономией топлива. На графике слева представлены данные по всем машинам

2.1. Пример прогнозирования экономии топлива 43

2010 года, на графике справа — данные только по новым машинам 2011 года. Очевидно, что с ростом объема двигателя эффективность потребления топлива падает независимо от года выпуска. Зависимость выглядит достаточно линейной, но на концах оси, отражающей изменение объема двигателя, наблюдается некоторая тенденция к искривлению.

2 4 6 8

-0- ф

70

60

50

40

30

20

2 4 6 8

Объем двигателя

Рис. 2.1. Зависимость между объемом двигателя и эффективностью потребления топлива для автомобилей 2010 и 2011 года выпуска

Если бы в модели использовалось несколько предикторов, то пришлось бы продолжить анализ их характеристик, а равно и зависимостей между предикторами. Эти характеристики могут указывать на обязательность выполнения ряда операций по обработке данных, предшествующих построению модели (подробнее см. главу 3).

Получив первое представление о данных, можно приступить к построению и оценке модели. Стандартный подход заключается в том, чтобы использовать случайную выборку данных для построения модели, а остальные данные — для оценки ее эффективности. Предположим, однако, что нам необходимо спрогнозировать MPG для нового семейства автомобилей. Подобные модели могут создаваться на основе данных 2010 года (для 1107 автомобилей), а тестироваться — на основе данных 2011 года (для 245 автомобилей). Условимся, что данные за 2010 год будут именоваться нами «тренировочным набором» модели, а данные за 2011 год — «тестовым» или «контрольным» набором.

Теперь необходимо решить, как именно оценивать эффективность модели. Для регрессионных задач, в которых мы пытаемся предсказать то или иное числовое значение, важным источником информации могут стать погрешности. Остаточная погрешность (residual) вычисляется как разность между наблюдаемым и спрогнозированным значением (то есть г/, - г/?) При прогнозировании числовых значений для оценки моделей обычно применяется среднеквадратичная погрешность. Эта

44 Глава 2. Краткий обзор процесса предиктивного моделирования характеристика (подробнее см. главу 7) показывает, насколько в среднем погрешность отклоняется от нуля.

В процессе оценки модели ее разработчик опробует различные приемы математического определения зависимости между предиктором и результатом. Здесь тренировочный набор используется для оценки различных значений, задействованных в уравнениях модели. Тестовый набор используется только после того, как несколько наиболее подходящих моделей (далее также — моделей-кандидатов) будут приняты разработчиком для окончательного выбора в пользу наиболее подходящей. Отметим, что повторное использование тестового набора в процессе построения модели не позволяет применять его в качестве «арбитра» модели.

Предположим, нами была создана модель линейной регрессии, в которой прогнозируемая величина MPG определяется простейшим уравнением прямой с угловым коэффициентом. На основании тренировочных данных мы посредством метода наименьших квадратов (подробнее см. раздел 6.2) оцениваем точку пересечения 50,6 и угловой коэффициент -4,5 MPG. На рис. 2.2 показана погрешность модели для данных тренировочного набора1. В левой части отображен тренировочный набор данных с линейной аппроксимацией, определяемой вычисленной точкой пересечения и угловым коэффициентом. В правой части отображены наблюдаемые и спрогнозированные значения MPG. Как видим, модель упускает некоторые закономерности в данных — например, занижение эффективности потребления топлива, если объем двигателя меньше 2 л или, напротив, больше 6 л.

70

к х X ф

7

X со

ф >ч

о.

60

50

40

30

20

ф

3

2

о Е а

с

2 4 6 8

20 30 40 50 60 70

Объем двигателя

Наблюдаемые значения

Рис. 2.2. Диагностика качества аппроксимации для модели линейной регрессии

1 Как говорил наш преподаватель в аспирантуре:« Если вы хотите чувствовать себя уверенно со своими данными, никогда не смотрите на них».

2.1. Пример прогнозирования экономии топлива 45

Подчеркнем: не следует оценивать производительность модели на данных, использованных для построения модели. Выполнив прогнозирование на основе данных тренировочного набора, вы рискуете получить завышенную оценку качества работы модели, особенно если модель обладает высокой адаптируемостью. Альтернативный способ оценки качества модели основан на использовании повторной выборки (resampling) с вариативным использованием данных тренировочного набора для обучения модели (подробнее см. главу 4). В рассматриваемом примере использован прием повторной выборки, именуемый далее десятикратной перекрестной проверкой (10-fold cross-validation); значение среднеквадратичной погрешности составляет 4,6 MPG.

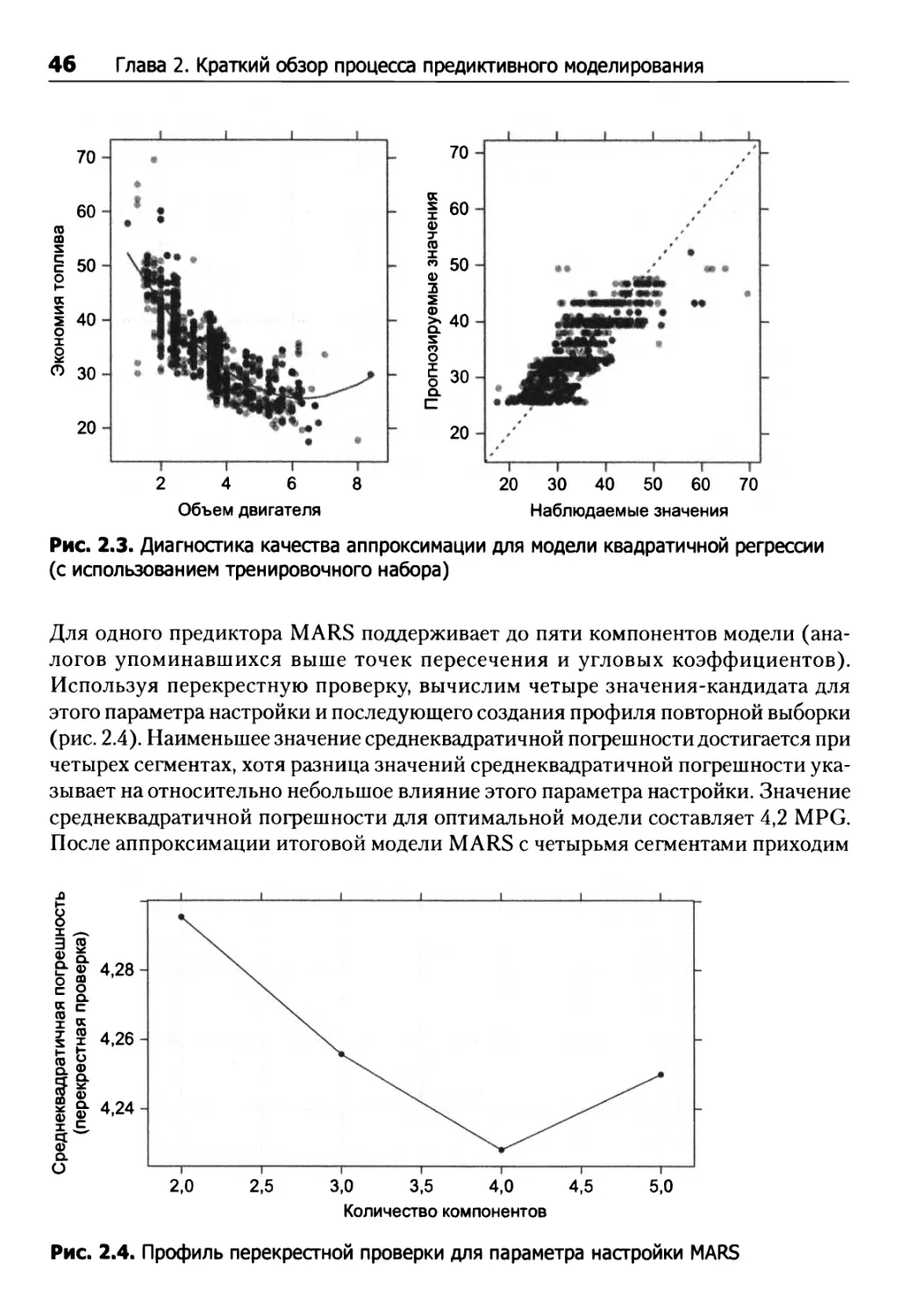

Исходя из рис. 2.2 можно предположить, что задача решается введением некоторой нелинейности в модель несколькими возможными способами — например, посредством искусственного усложнения вычислительного аппарата модели. Так, добавление квадратного члена для объема двигателя позволяет дополнительно оценить параметр углового коэффициента (через квадрат предиктора). В этом случае уравнение модели принимает вид:

Эффективность = 63,2 - 11,9 х объем + 0,94 х объем2.

Такое уравнение называется квадратичной моделью, поскольку включает квадратный член (см. аппроксимацию модели на рис. 2.3). Добавление квадратного члена улучшает качество аппроксимации — значение среднеквадратичной погрешности, вычисленной с использованием перекрестной проверки, составляет 4,2 MPG. Один из недостатков квадратичных моделей — неэффективность в крайних диапазонах предиктора. На рис. 2.3 нечто похожее наблюдается для автомобилей с очень большим объемом двигателя. Результаты подобного прогнозирования могут характеризоваться серьезными погрешностями.

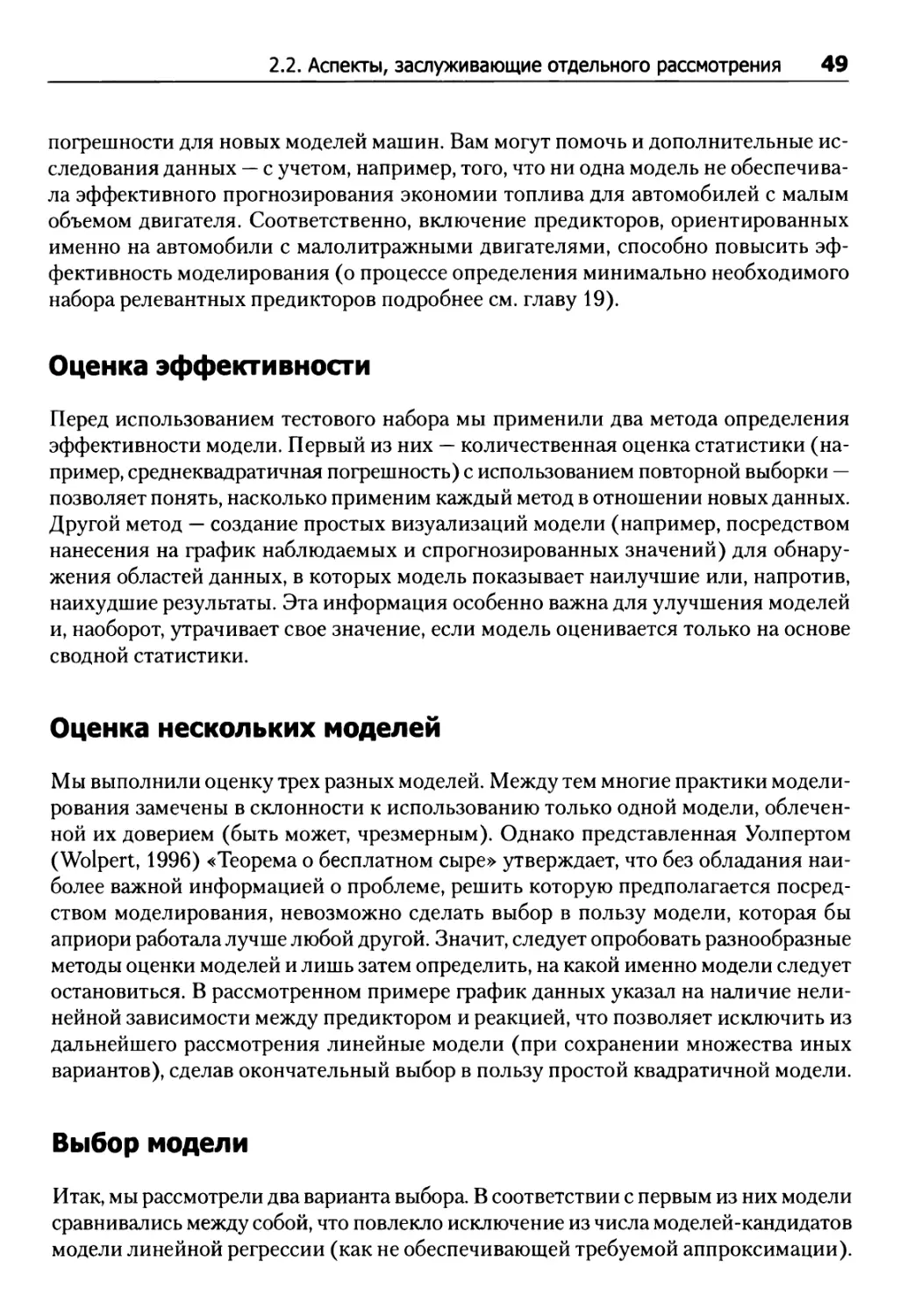

В главах 6-8 рассматривается немало других методов создания сложных зависимостей между предикторами и результатом. Это, например, рассмотренная Фридманом (Friedman, 1991) модель многомерных адаптивных регрессионных сплайнов (MARS). При наличии только одного предиктора MARS может произвести аппроксимацию разных линейных регрессий для разных диапазонов объема двигателя. Для этой модели вычисляется точка пересечения оси и угловой коэффициент, а также количество и размеры нескольких областей для линейных моделей. В отличие от линейных регрессионных моделей, у модели, формируемой рассматриваемым методом, имеется параметр настройки, который не может быть напрямую выведен из данных. Не существует и формулы, по которой можно было бы определить количество сегментов для моделирования данных. Хотя в модели MARS предусмотрены внутренние алгоритмы для определения этой характеристики, можно опробовать разные значения и использовать повторную выборку для определения наиболее подходящего из них. Это позволит провести обучение итоговой модели MARS по всем данным тренировочного набора, после чего использовать ее для прогнозирования.

46 Глава 2. Краткий обзор процесса предиктивного моделирования

70

60 га га х £ 50 О н (X i 40 О х § & 30

20

70

(1)

3

ф >ч

Q.

X о О г о Q.

60

50

40

30

С

2 4 6 8

20 30 40 50 60 70

Объем двигателя

Наблюдаемые значения

Рис. 2.3. Диагностика качества аппроксимации для модели квадратичной регрессии (с использованием тренировочного набора)

Для одного предиктора MARS поддерживает до пяти компонентов модели (аналогов упоминавшихся выше точек пересечения и угловых коэффициентов). Используя перекрестную проверку, вычислим четыре значения-кандидата для этого параметра настройки и последующего создания профиля повторной выборки (рис. 2.4). Наименьшее значение среднеквадратичной погрешности достигается при четырех сегментах, хотя разница значений среднеквадратичной погрешности указывает на относительно небольшое влияние этого параметра настройки. Значение среднеквадратичной погрешности для оптимальной модели составляет 4,2 MPG. После аппроксимации итоговой модели MARS с четырьмя сегментами приходим

2,0

2,5

3,0 3,5 4,0 4,5

Количество компонентов

5,0

Рис. 2.4. Профиль перекрестной проверки для параметра настройки MARS

2.1. Пример прогнозирования экономии топлива 47

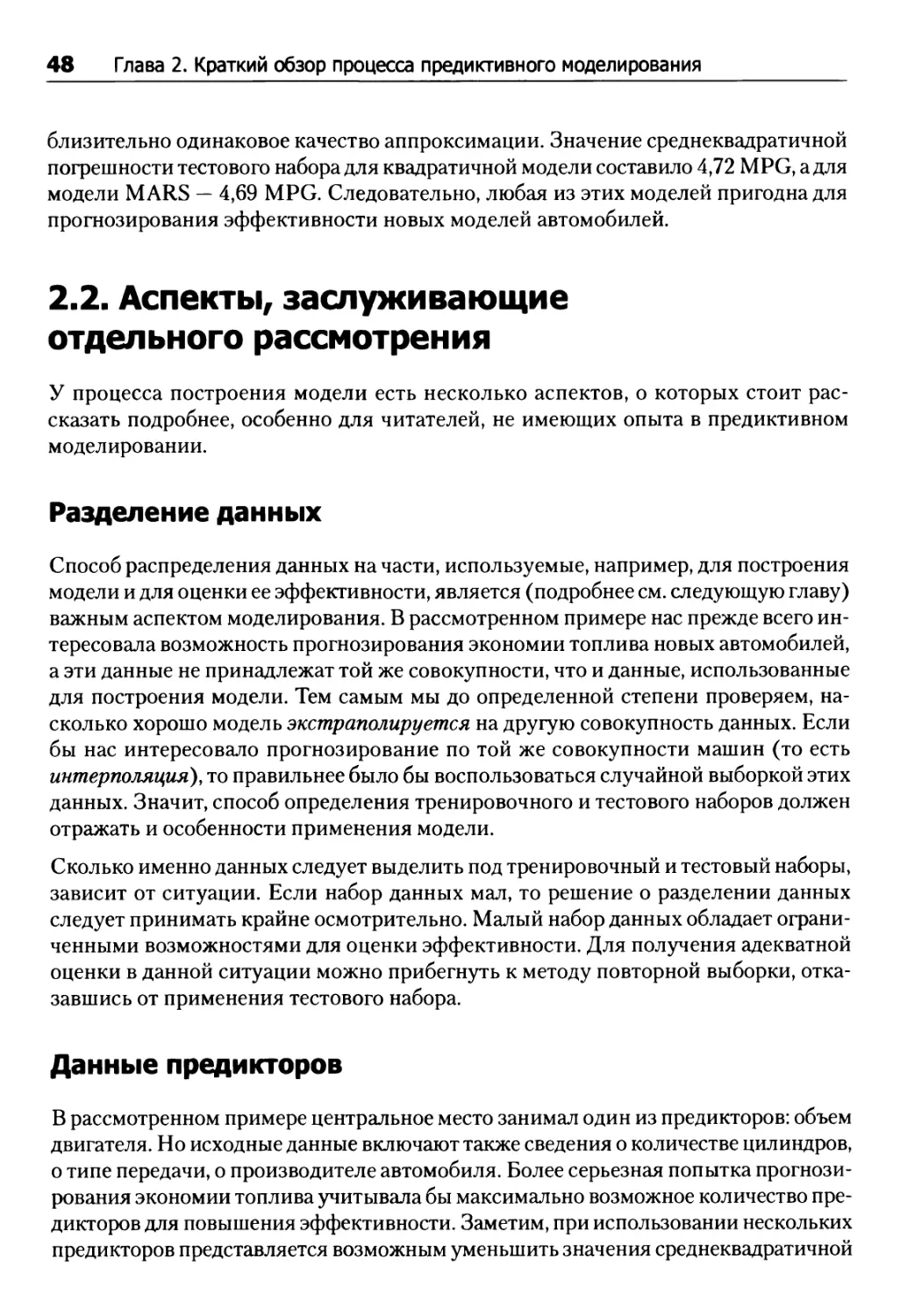

к значениям тренировочного набора (рис. 2.5), для которого было также спрогнозировано несколько линейных сегментов.

70

2 4 6 8

Объем двигателя

(X X X ф т го X со

ф

5

ф >4

о.

о о. С

60

50

40

30

20

20 30 40 50 60 70

Наблюдаемые значения

Рис. 2.5. Диагностика качества аппроксимации для модели MARS

(с использованием тренировочного набора). Модель MARS создает несколько вариантов линейной регрессии с точками изменений в 2,3, 3,5 и 4,3 л

2 3 4 5 6 7

60

S 50

х

q

О

о

О 30 О

20

2 3 4 5 6 7

Объем двигателя

Рис. 2.6. Данные тестового набора и результаты аппроксимации для двух моделей

На основании этих трех моделей для тестового набора проведена оценка модели квадратичной регрессии и модели MARS (рис. 2.6). Обе модели обеспечивают при-

48 Глава 2. Краткий обзор процесса предиктивного моделирования близительно одинаковое качество аппроксимации. Значение среднеквадратичной погрешности тестового набора для квадратичной модели составило 4,72 MPG, а для модели MARS — 4,69 MPG. Следовательно, любая из этих моделей пригодна для прогнозирования эффективности новых моделей автомобилей.

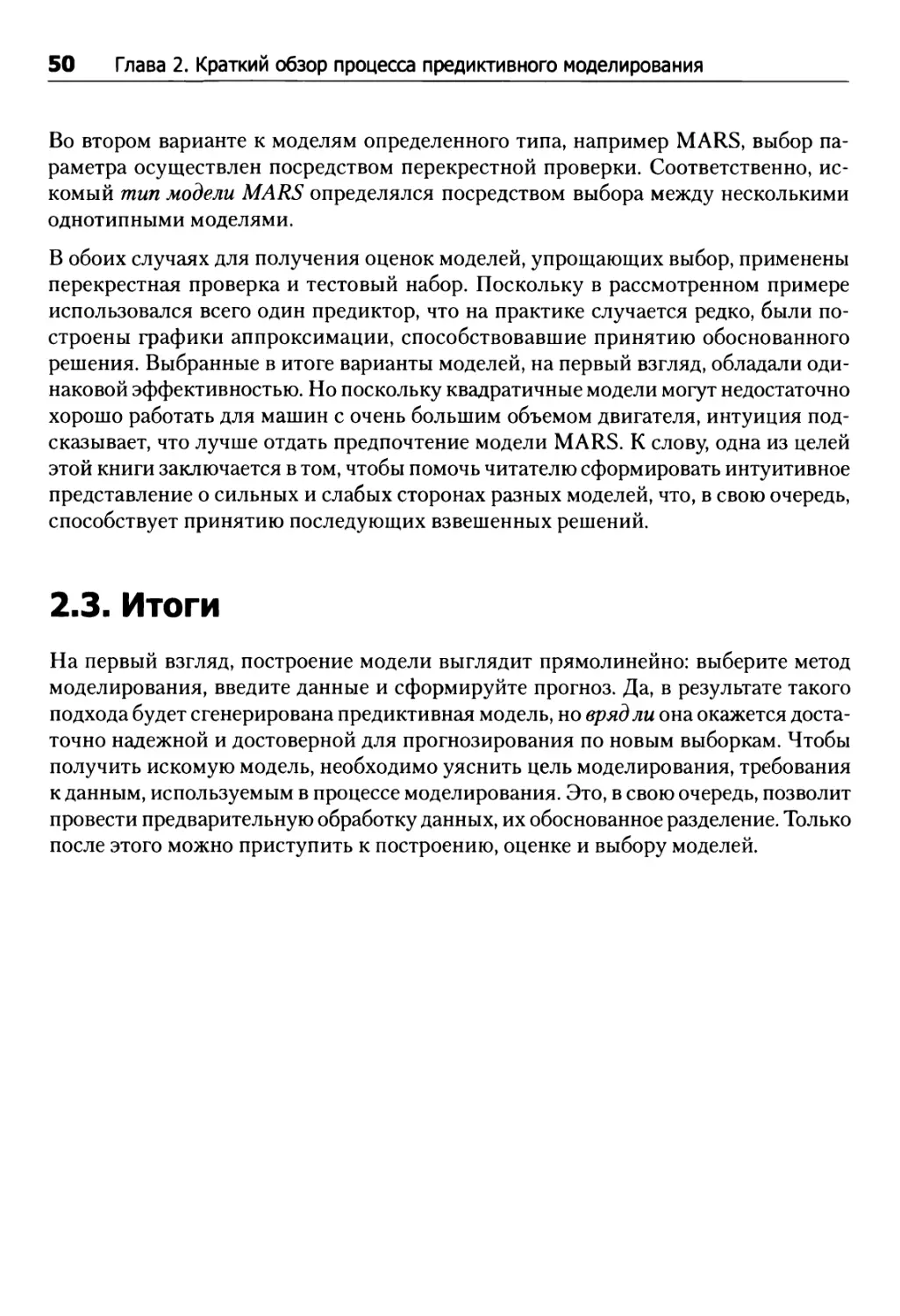

2.2. Аспекты, заслуживающие отдельного рассмотрения

У процесса построения модели есть несколько аспектов, о которых стоит рассказать подробнее, особенно для читателей, не имеющих опыта в предиктивном моделировании.

Разделение данных

Способ распределения данных на части, используемые, например, для построения модели и для оценки ее эффективности, является (подробнее см. следующую главу) важным аспектом моделирования. В рассмотренном примере нас прежде всего интересовала возможность прогнозирования экономии топлива новых автомобилей, а эти данные не принадлежат той же совокупности, что и данные, использованные для построения модели. Тем самым мы до определенной степени проверяем, насколько хорошо модель экстраполируется на другую совокупность данных. Если бы нас интересовало прогнозирование по той же совокупности машин (то есть интерполяция), то правильнее было бы воспользоваться случайной выборкой этих данных. Значит, способ определения тренировочного и тестового наборов должен отражать и особенности применения модели.

Сколько именно данных следует выделить под тренировочный и тестовый наборы, зависит от ситуации. Если набор данных мал, то решение о разделении данных следует принимать крайне осмотрительно. Малый набор данных обладает ограниченными возможностями для оценки эффективности. Для получения адекватной оценки в данной ситуации можно прибегнуть к методу повторной выборки, отказавшись от применения тестового набора.

Данные предикторов

В рассмотренном примере центральное место занимал один из предикторов: объем двигателя. Но исходные данные включают также сведения о количестве цилиндров, о типе передачи, о производителе автомобиля. Более серьезная попытка прогнозирования экономии топлива учитывала бы максимально возможное количество предикторов для повышения эффективности. Заметим, при использовании нескольких предикторов представляется возможным уменьшить значения среднеквадратичной

2.2. Аспекты, заслуживающие отдельного рассмотрения 49

погрешности для новых моделей машин. Вам могут помочь и дополнительные исследования данных — с учетом, например, того, что ни одна модель не обеспечивала эффективного прогнозирования экономии топлива для автомобилей с малым объемом двигателя. Соответственно, включение предикторов, ориентированных именно на автомобили с малолитражными двигателями, способно повысить эффективность моделирования (о процессе определения минимально необходимого набора релевантных предикторов подробнее см. главу 19).

Оценка эффективности

Перед использованием тестового набора мы применили два метода определения эффективности модели. Первый из них — количественная оценка статистики (например, среднеквадратичная погрешность) с использованием повторной выборки — позволяет понять, насколько применим каждый метод в отношении новых данных. Другой метод — создание простых визуализаций модели (например, посредством нанесения на график наблюдаемых и спрогнозированных значений) для обнаружения областей данных, в которых модель показывает наилучшие или, напротив, наихудшие результаты. Эта информация особенно важна для улучшения моделей и, наоборот, утрачивает свое значение, если модель оценивается только на основе сводной статистики.

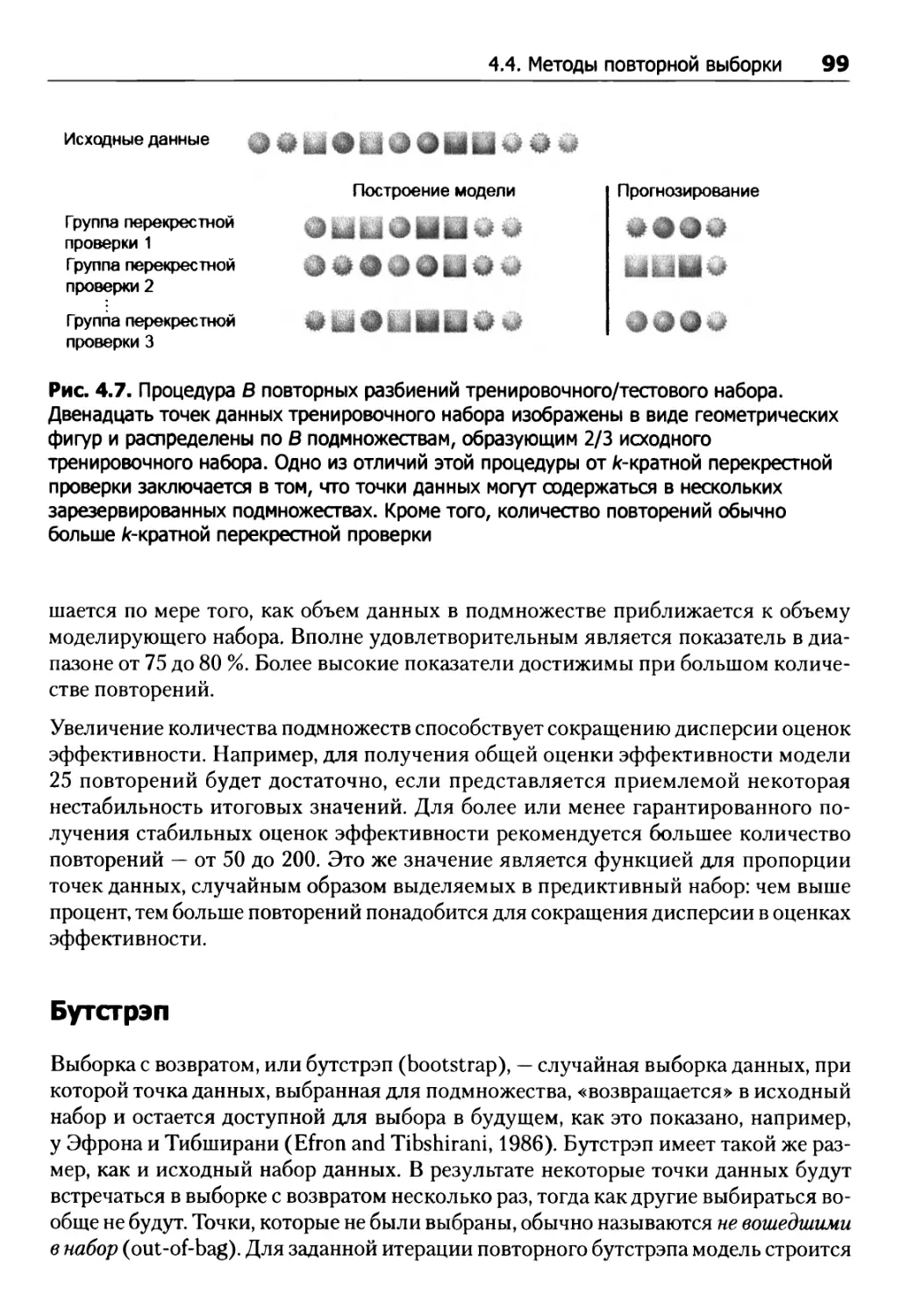

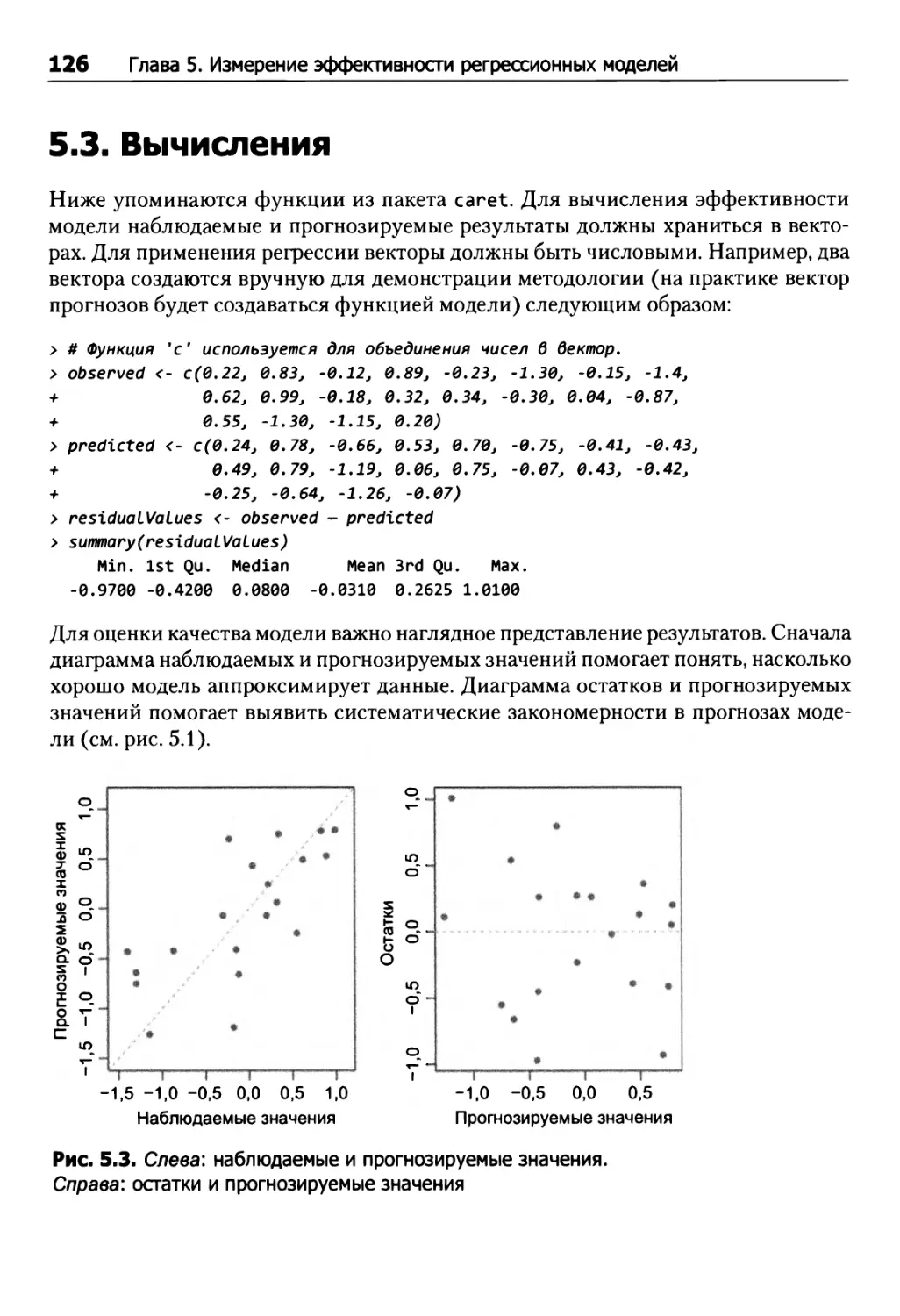

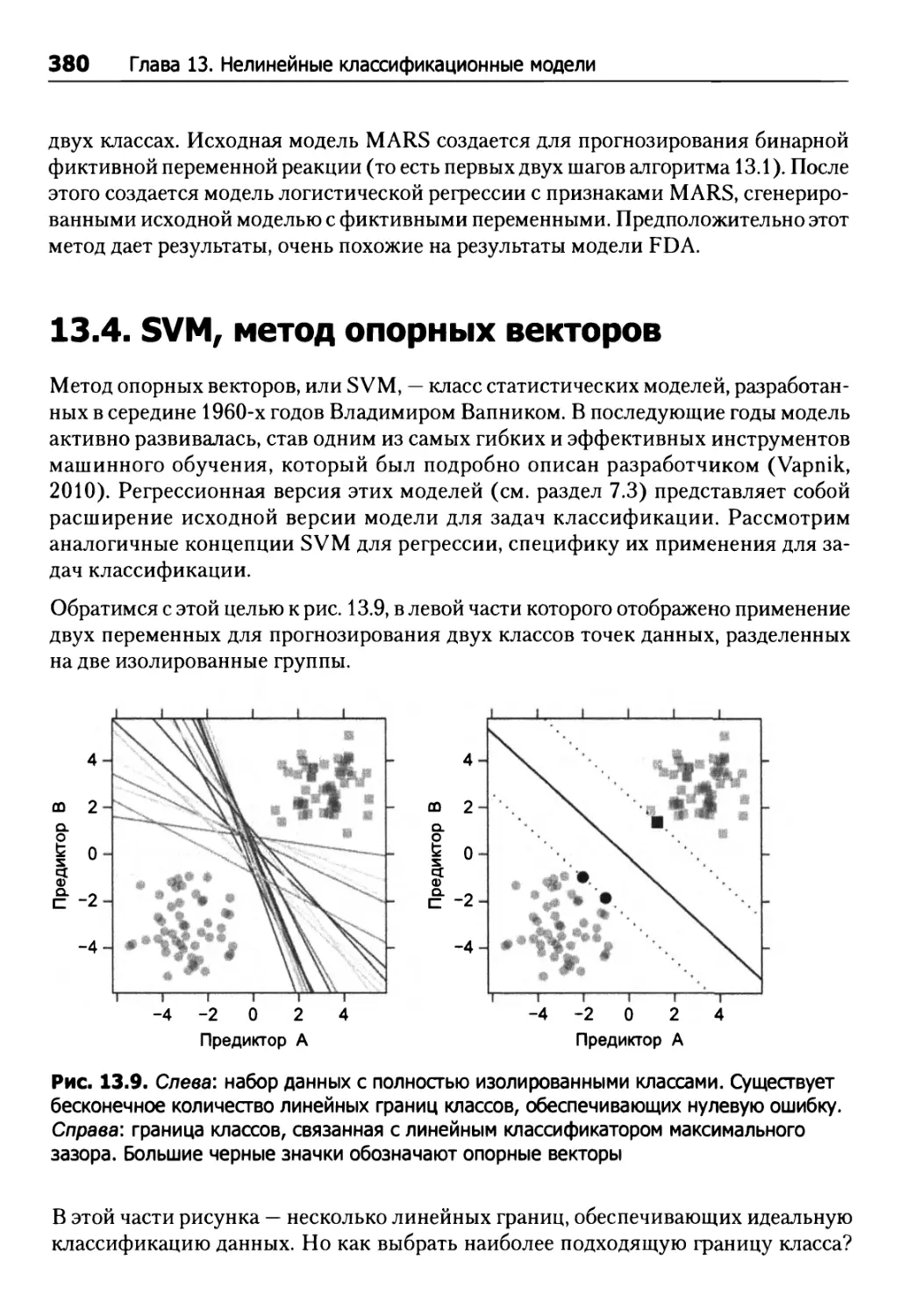

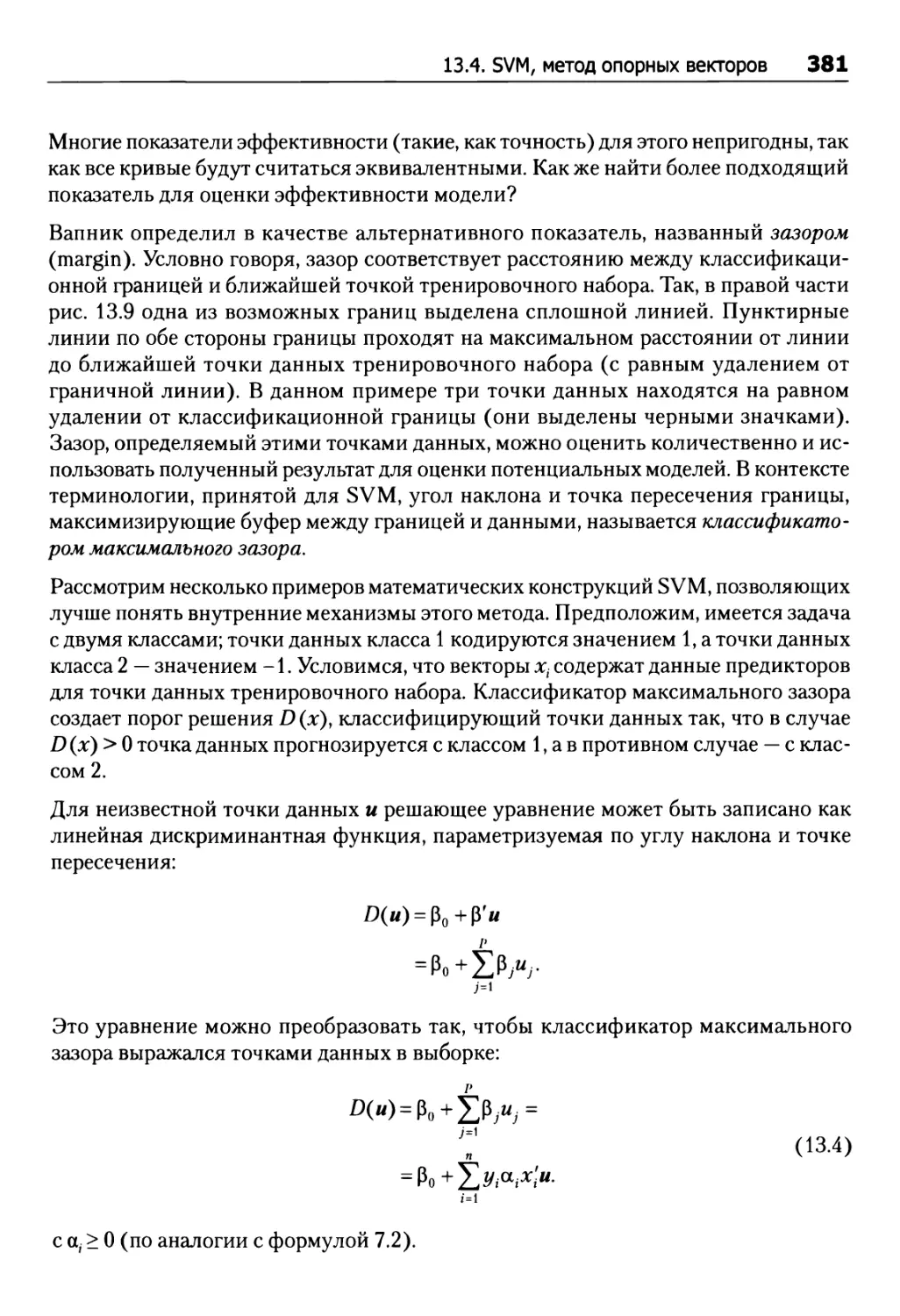

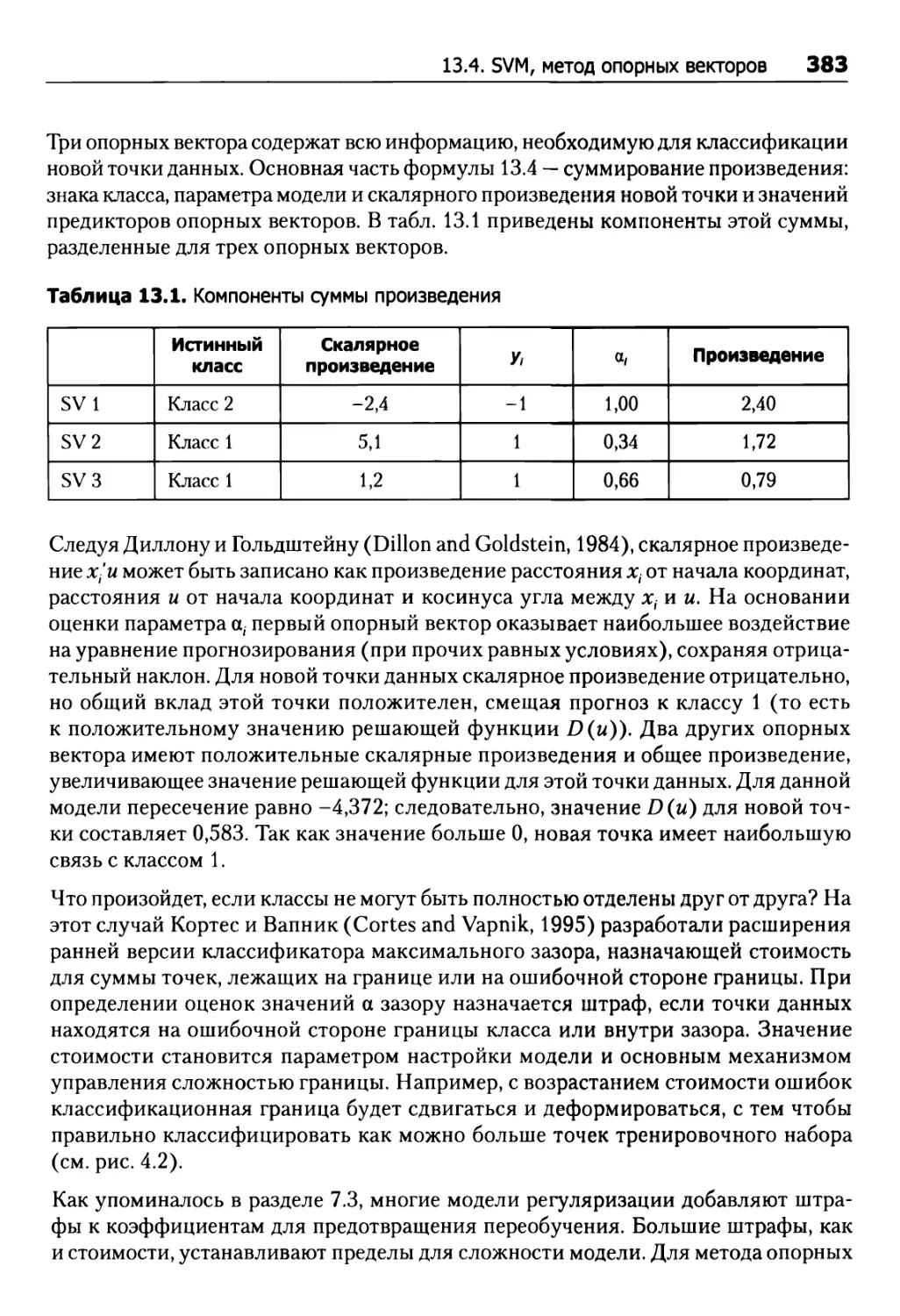

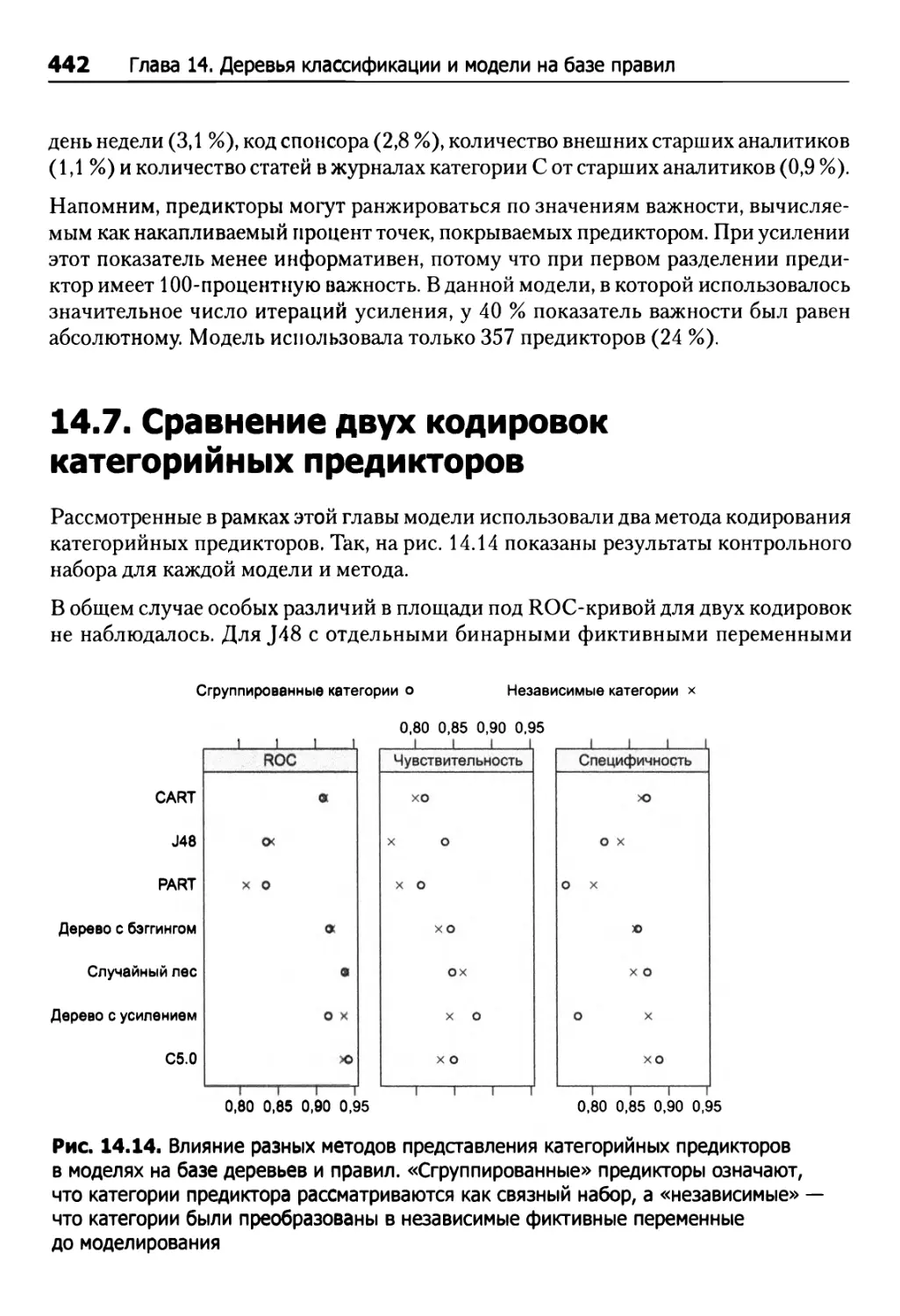

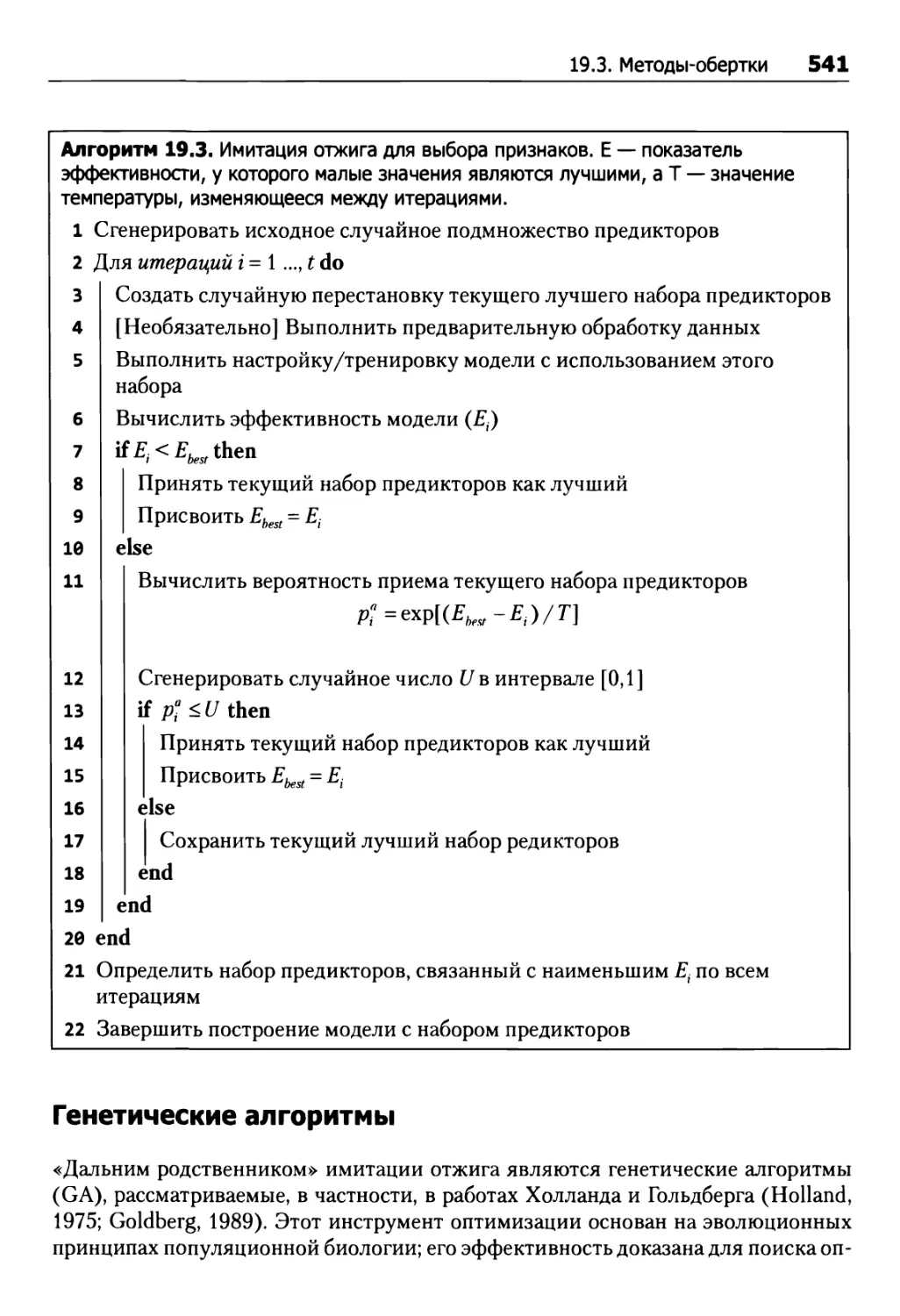

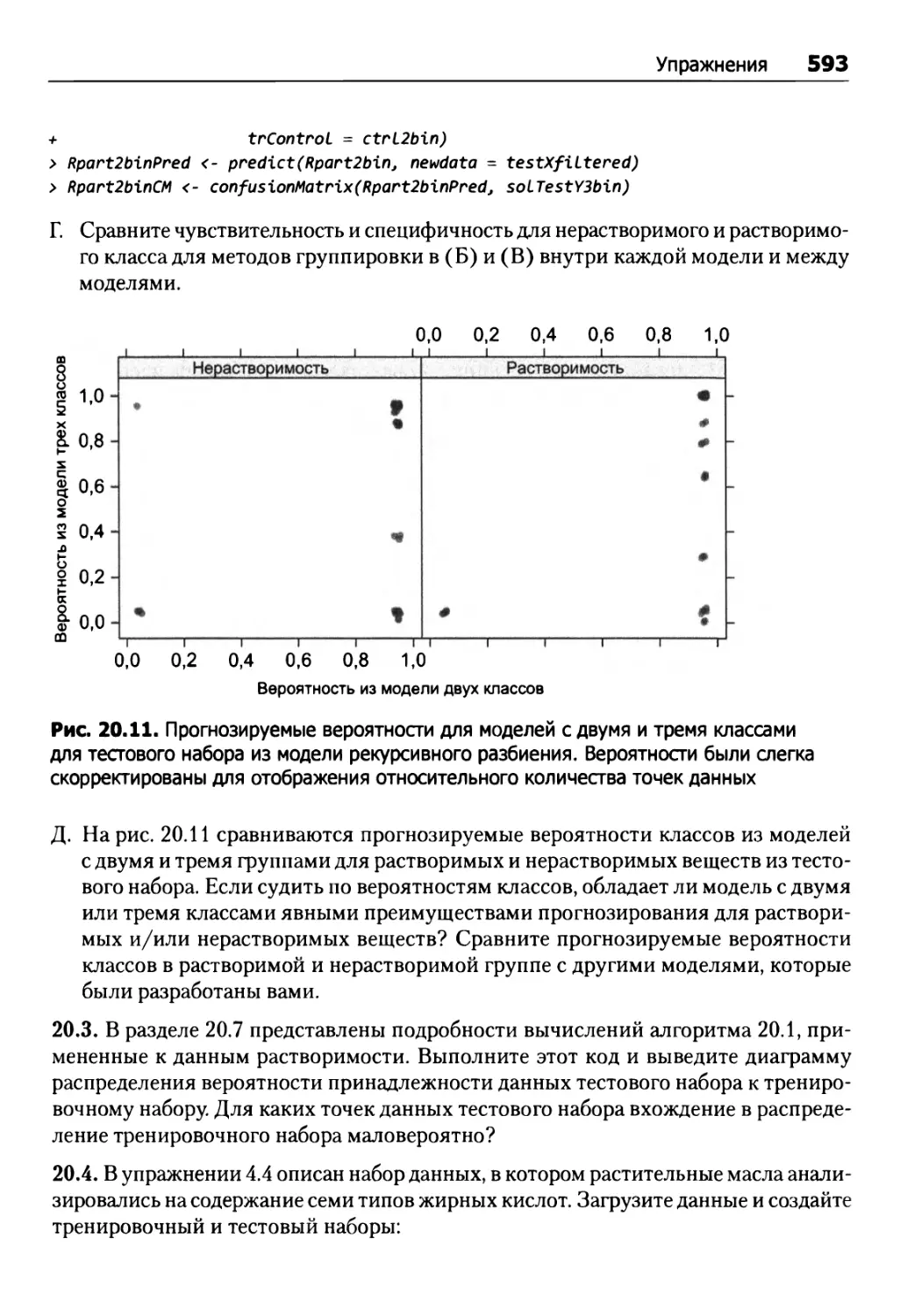

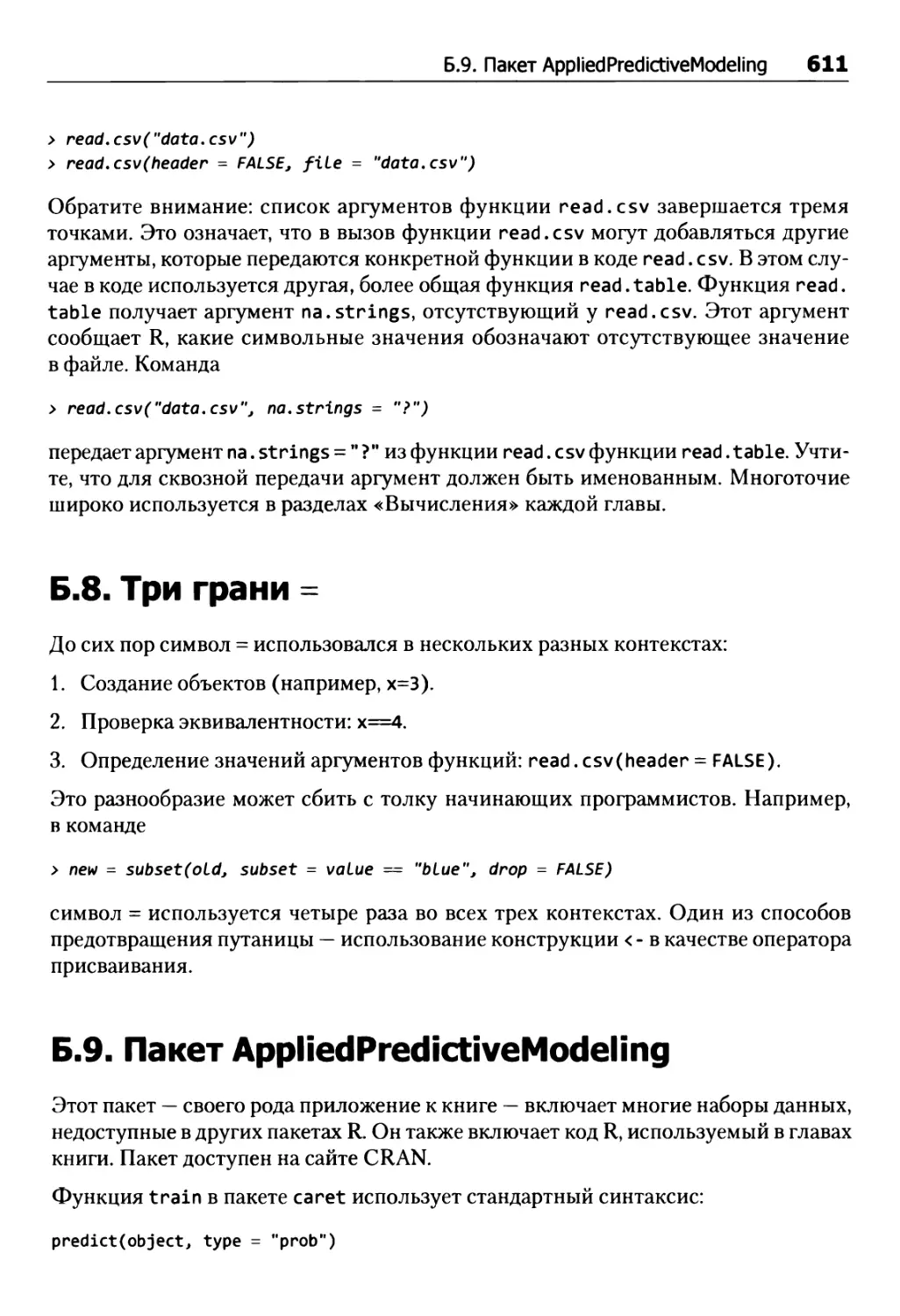

Оценка нескольких моделей