Автор: Синицын И.Н.

Теги: вычислительная математика численный анализ математика информатика высшая математика прикладная математика

ISBN: 5-98704-058-2

Год: 2006

Текст

И.Н. СИНИЦЫН

ФИЛЬТРЫ КАЛ

И ПУГАЧЕВА

ФИЛЬТРЫ

КАЛ МАНА

И ПУГАЧЕВА

И.Н. Синицын

И.Н. Синицын

ФИЛЬТРЫ

КАЛМАНА И ПУГАЧЕВА

К

Москва

«Логос»

2006

УДК 519.62

ББК 22.193

С38

Издание осуществлено при поддержке

Российского фонда фундаментальных исследований

Издательский проект 05-01-14043

Синицын И.Н.

С38 Фильтры Калмана и Пугачева: Учеб, пособие. - М.: Универ-

ситетская книга, Логос, 2006. - 640 с.: ил.

ISBN 5-98704-058-2

Дается систематическое изложение теории линейного оценивания

(фильтрации, экстраполяции и интерполяции) процессов в непрерыв-

ных и дискретных стохастических системах на основе фильтров Калма-

на и их обобщений. Подробно излагается теория нелинейного условно

оптимального (по Пугачеву) оценивания. Фильтры Калмана и Пугаче-

ва лежат в основе современных методов оперативной обработки ин-

формации. Для усвоения излагаемых методов приводятся необходимые

сведения из теории стохастических систем и библиографические заме-

чания, а также свыше 300 примеров и задач для упражнений.

Для математиков, физиков, специалистов в области информатики,

радиотехники, теории управления и связи, радиолокации, навигацион-

ной аппаратуры. Может использоваться в учебном процессе высших

учебных заведений при подготовке специалистов и магистров по на-

правлению и специальности «Прикладная математика и информатика».

ББК 22.193

ISBN 5-98704-058-2

© Синицын И.Н., 2006

© «Университетская книга», 2006

© «Логос», 2006

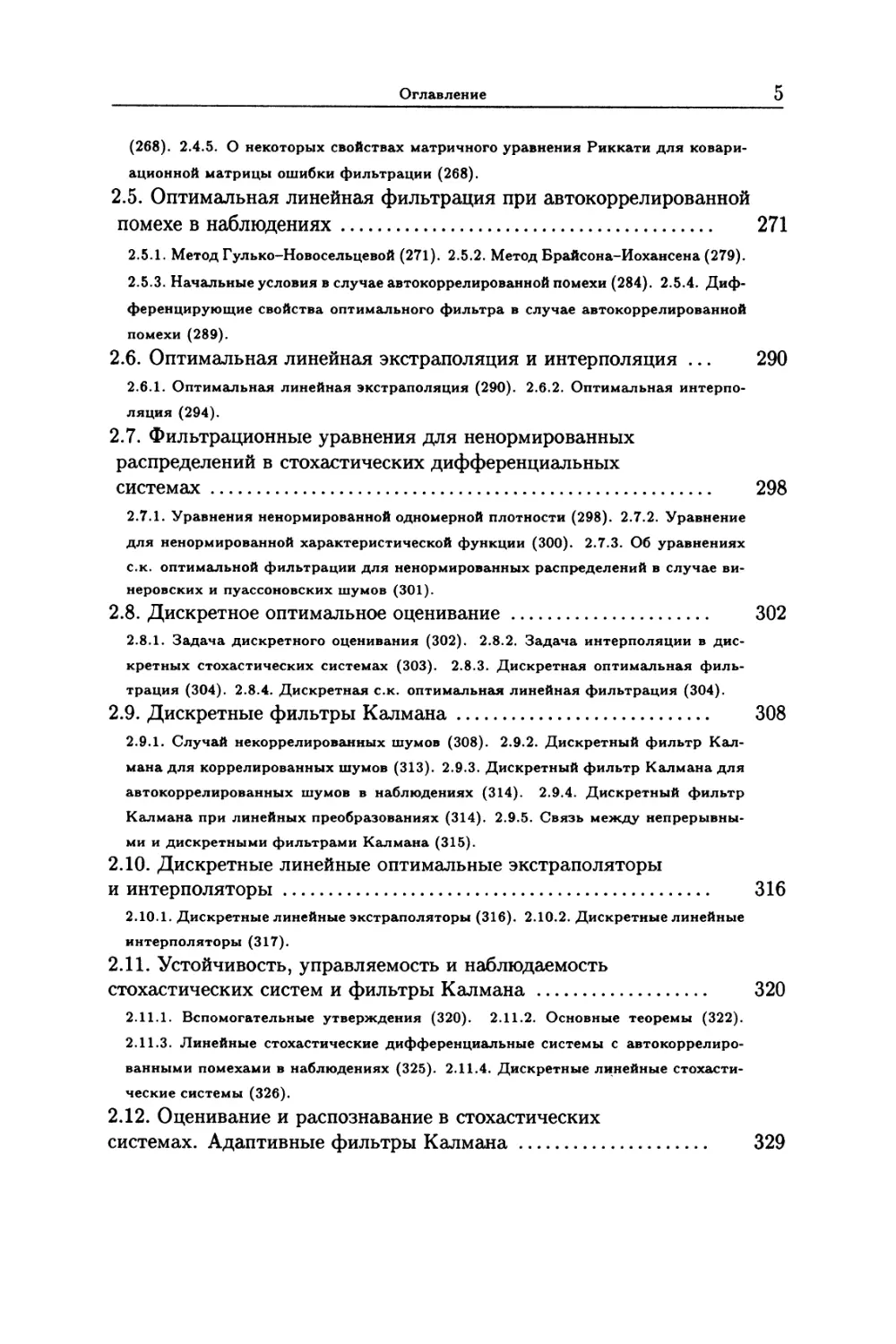

ОГЛАВЛЕНИЕ

Предисловие............................................. 9

Г л а в а 1. Сведения из теории стохастических систем ... 15

1.1. Математические модели систем и их характеристики . 15

1.1.1. Математические модели непрерывных систем (15). 1.1.2. Линейные диффе-

ренциальные системы (25). 1.1.3. Соединения систем и их характеристики (26).

1.1.4. Стохастические дифференциальные системы (31). 1.1.5. Дискретные сто-

хастические системы (33). 1.1.6. Устойчивость, управляемость и наблюдаемость

линейных систем (45).

1.2. Случайные функции ............................................. 53

1.2.1. Вероятностные пространства (53). 1.2.2. Случайные величины (55).

1.2.3. Условные вероятности (56). 1.2.4. Вероятности в конечных произведени-

ях пространств (60). 1.2.5. О вероятностях в бесконечных произведениях про-

странств (65). 1.2.6. Определения и вероятностные меры случайной функции (67).

1.2.7. Некоторые типовые случайные процессы (70). 1.2.8. Вероятности событий,

связанных со случайными функциями (77).

1.3. Моменты, характеристические функции и функционалы ... 78

1.3.1. Математическое ожидание случайной величины (78). 1.3.2. Моменты вто-

рого порядка (80). 1.3.3. Моменты высших порядков (86). 1.3.4. Характеристи-

ческие функции и функционалы (88). 1.3.5. Ортогональные разложения одно- и

многомерных плотностей. Семиинварианты и квазимоменты (91). 1.3.6. Условные

моменты (103).

1.4. Элементы стохастического анализа.............................. 109

1.4.1. Операции анализа над случайными функциями (109). 1.4.2. Интегрирование

случайной функции по неслучайной мере (115). 1.4.3. Интегрирование функций

по случайной мере (118). 1.4.4. Стохастические интегралы (121). 1.4.5. Стохасти-

ческие дифференциалы (132).

1.5. Распределения процессов в стохастических системах.......... 137

1.5.1. Стохастические дифференциальные уравнения (137). 1.5.2. Приведение

уравнений непрерывной стохастической системы к стохастическим дифференци-

альным уравнениям (140). 1.5.3. О численном интегрировании уравнений стоха-

стических дифференциальных систем (144). 1.5.4. Одно- и многомерные распре-

деления в стохастических дифференциальных системах (145). 1.5.5. Одно- и мно-

гомерные распределения в дискретных и непрерывно-дискретных системах (154).

1.6. Методы теории линейных стохастических систем ................. 156

1.6.1. Методы спектрально-корреляционной теории линейных стохастических си-

стем (156). 1.6.2. Методы общей теории линейных стохастических систем (163).

1.7. Методы теории нелинейных стохастических систем (I).

Нормальная аппроксимация и эквивалентная линеаризация .. 169

1.7.1. Моменты вектора состояния. Линейные системы с параметрическими шу-

4

Оглавление

мами (169). 1.7.2. Методы нормальной аппроксимации и эквивалентной линеари-

зации (175).

1.8. Методы теории нелинейных стохастических систем (II).

Параметризация распределений .............................. 182

1.8.1. Вводные замечания (182). 1.8.2. Метод моментов (182). 1.8.3. Методы ор-

тогональных разложений к квазимоментов (193). 1.8.4. Структурная параметри-

зация распределений. Методы эллипсоидальной аппроксимации и линеаризации

(203).

1.9. Дополнения и задачи .................................. 210

Г л а в а 2. Оптимальное оценивание. Фильтры Калмана 237

2.1. Задачи оценивания в стохастических дифференциальных

системах................................................... 237

2.1.1. Оценивание состояния системы (237). 2.1.2. Оценивание неизвестных па-

раметров системы (239). 2.1.3. Экстраполяция состояния системы (240). 2.1.4.

'Постановка математических задач оценивания и экстраполяции в стохастических

дифференциальных системах (240). 2.1.5. Особенности постановок задач интер-

поляции в стохастических дифференциальных системах (242).

2.2. Оптимальная фильтрация в стохастических

дифференциальных системах ...................................... 243

2.2.1. Общая формула для оптимальной оценки (243). 2.2.2. Вспомогательная за-

дача (244). 2.2.3. Преобразование уравнений (245). 2.2.4. Стохастический диф-

ференциал оптимальной оценки функции состояния системы (247). 2.2.5. Урав-

нения для апостериорной характеристической функции (248). 2.2.6. Уравнение

для апостериорной плотности (249). 2.2.7. Стохастический дифференциал апосте-

риорного математического ожидания (250). 2.2.8. Стохастический дифференциал

апостериорного момента второго порядка (251). 2.2.9. Стохастический дифферен-

циал апостериорной ковариационной матрицы (253). 2.2.10. Применение теории

оптимальной фильтрации для оценивания параметров в уравнениях стохастиче-

ских дифференциальных систем (255). 2.2.11. О возможности решения задач

оптимальной фильтрации при автокоррелированной помехе в наблюдениях (255).

2.2.12. Об уравнениях с.к. оптимальной фильтрации в случае винеровских и

пуассоновских шумов (256).

2.3. Оптимальная линейная фильтрация в стохастических

дифференциальных системах .................................... 258

2.3.1. Уравнения линейной фильтрации (258). 2.3.2. Обновляющие процессы (261).

2.3.3. Случай уравнений, линейных относительно вектора состояния (261)

2.4. Линейные фильтры Калмана-Бьюси .......................... 263

3,4.1. Вводные замечания (263). 2.4.2. Об одной форме уравнений фильтра Кал-

мана-Бьюси (266). 2.4.3. Фильтры Калмана-Бьюси для стационарных систем

(267). 2.4.4. Связь между стационарными фильтрами Винера и Калмана-Бьюси

Оглавление

5

(268) . 2.4.5. О некоторых свойствах матричного уравнения Риккати для ковари-

ационной матрицы ошибки фильтрации (268).

2.5. Оптимальная линейная фильтрация при автокоррелированной

помехе в наблюдениях.............................................. 271

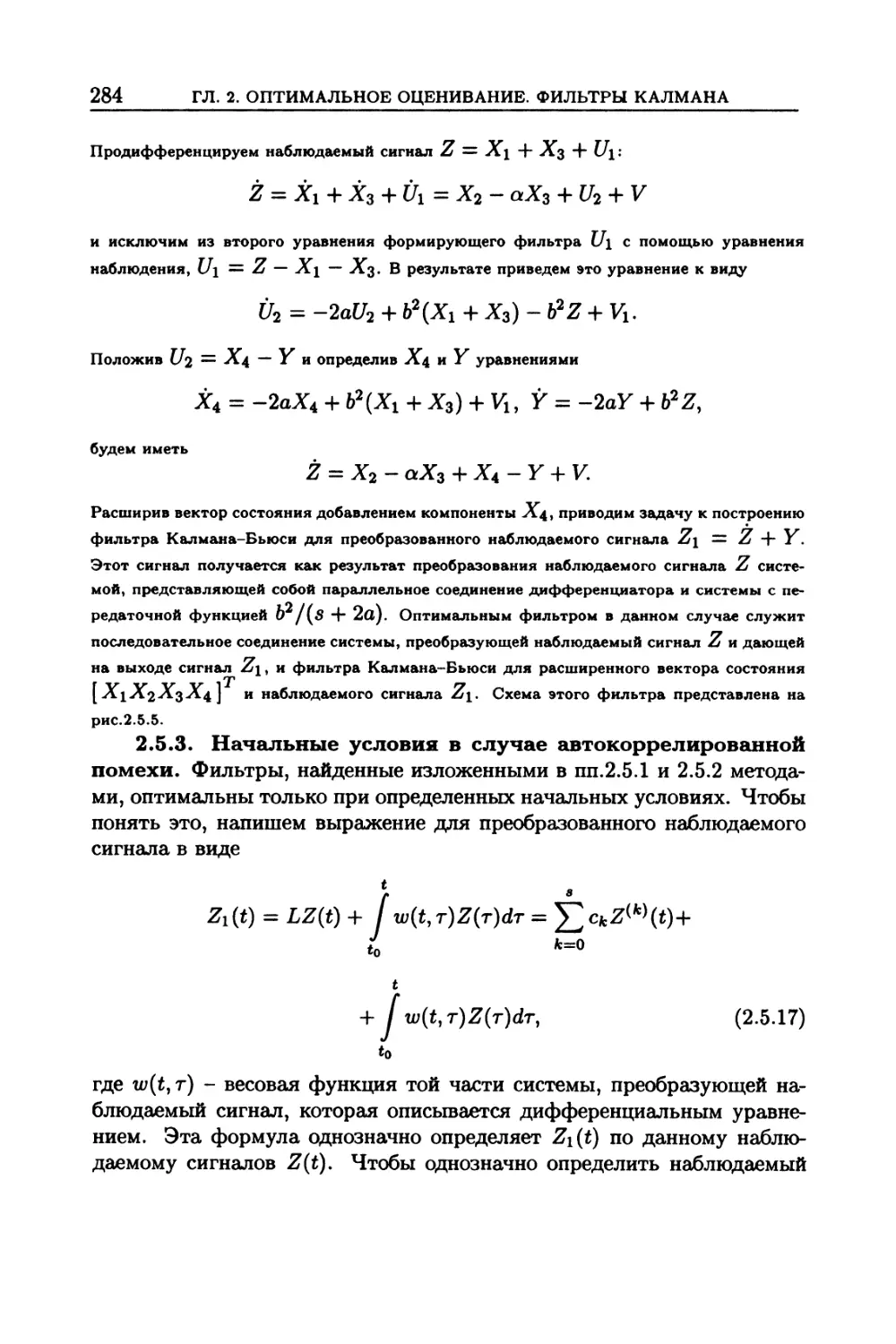

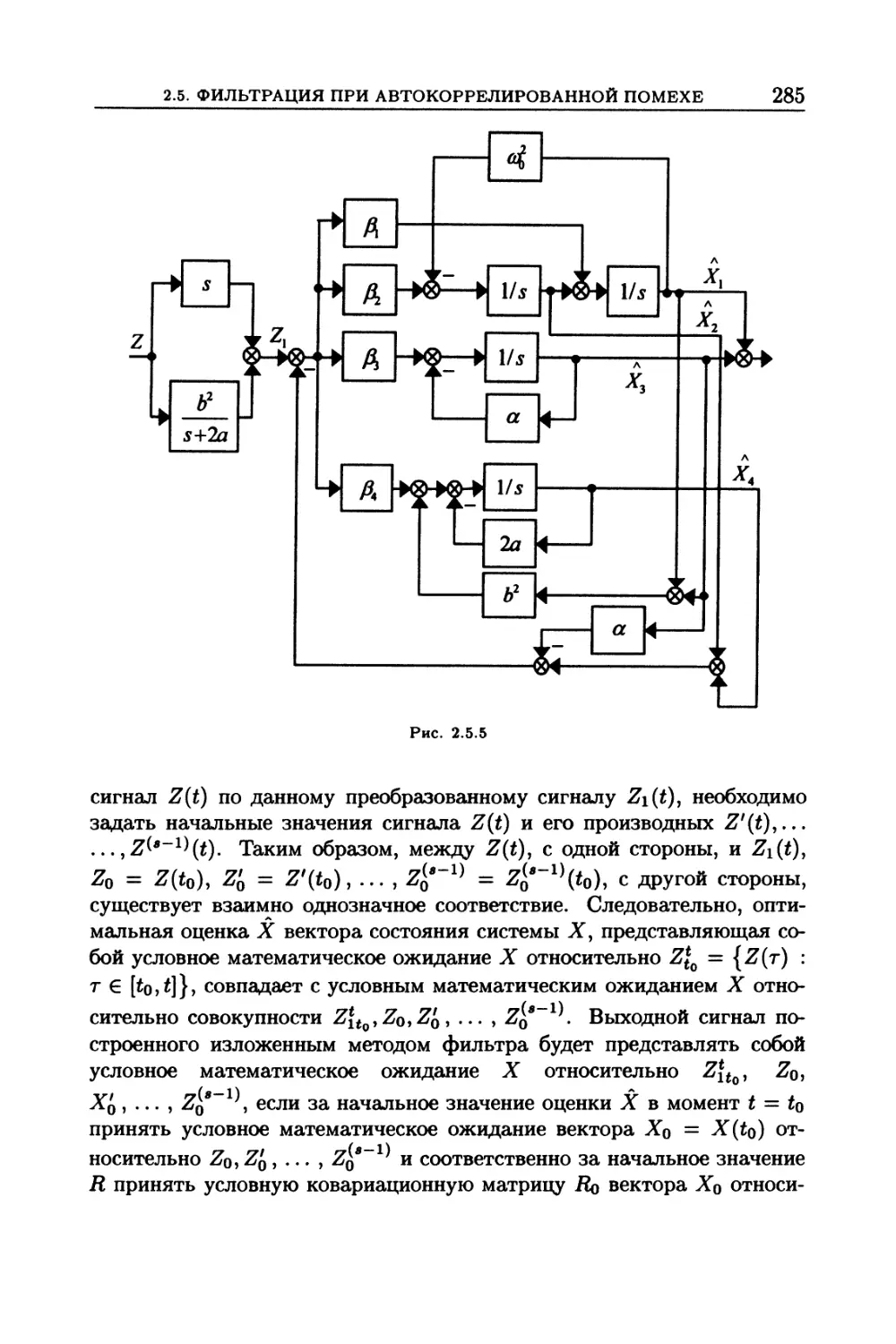

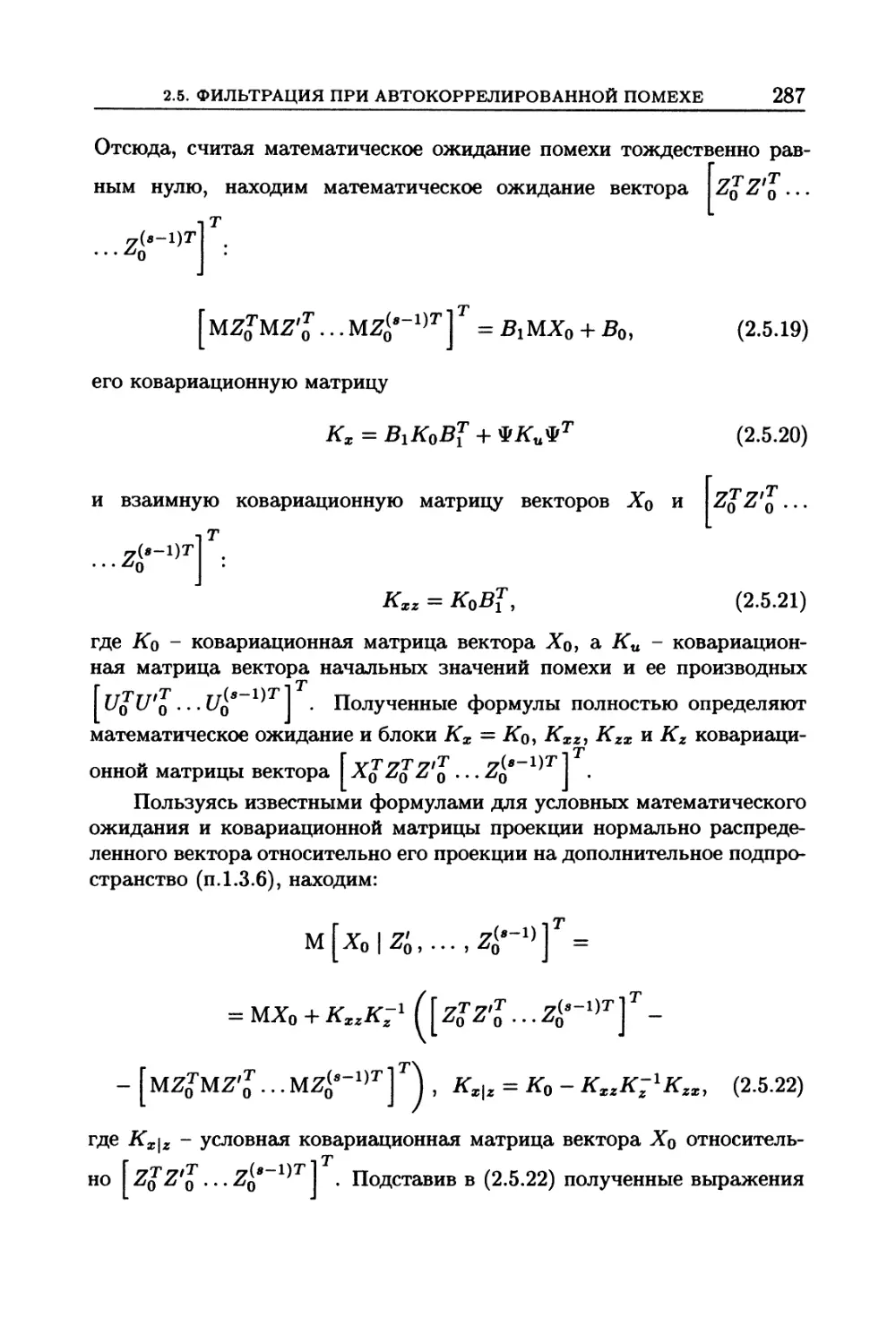

2.5.1. Метод Гулько-Новосельцевой (271). 2.5.2. Метод Брайсона-Йохансена (279).

2.5.3. Начальные условия в случае автокоррелированной помехи (284). 2.5.4. Диф-

ференцирующие свойства оптимального фильтра в случае автокоррелированной

помехи (289).

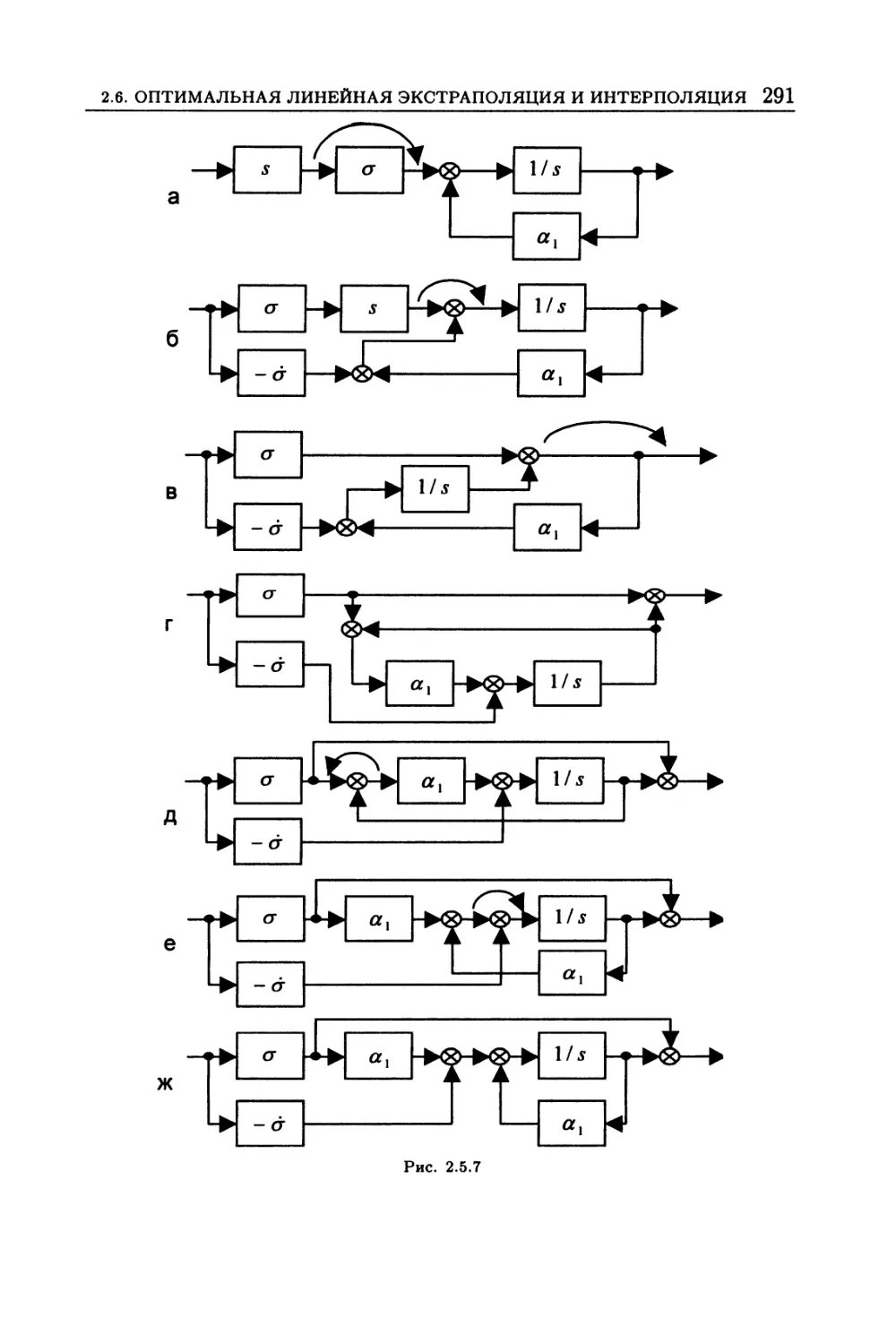

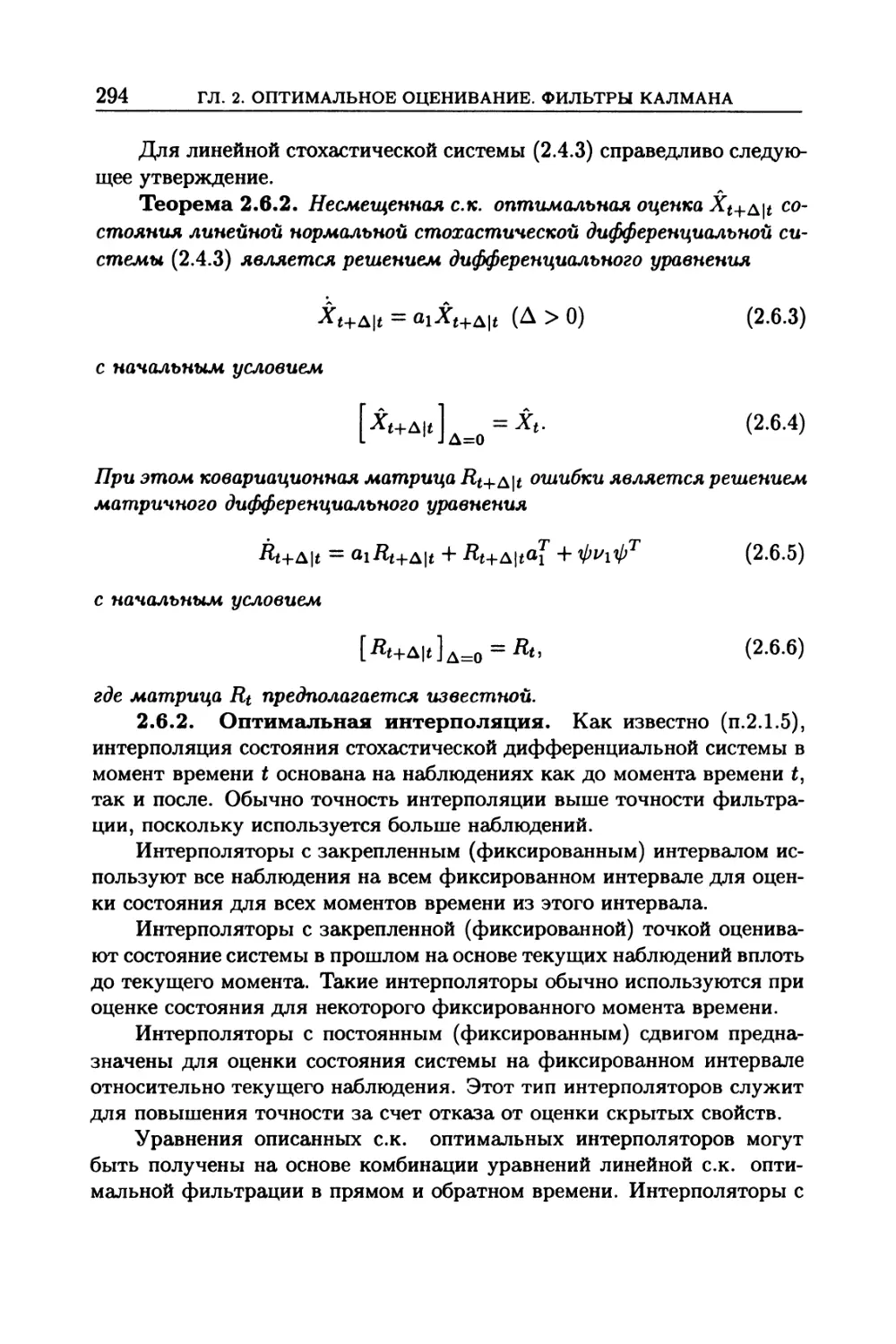

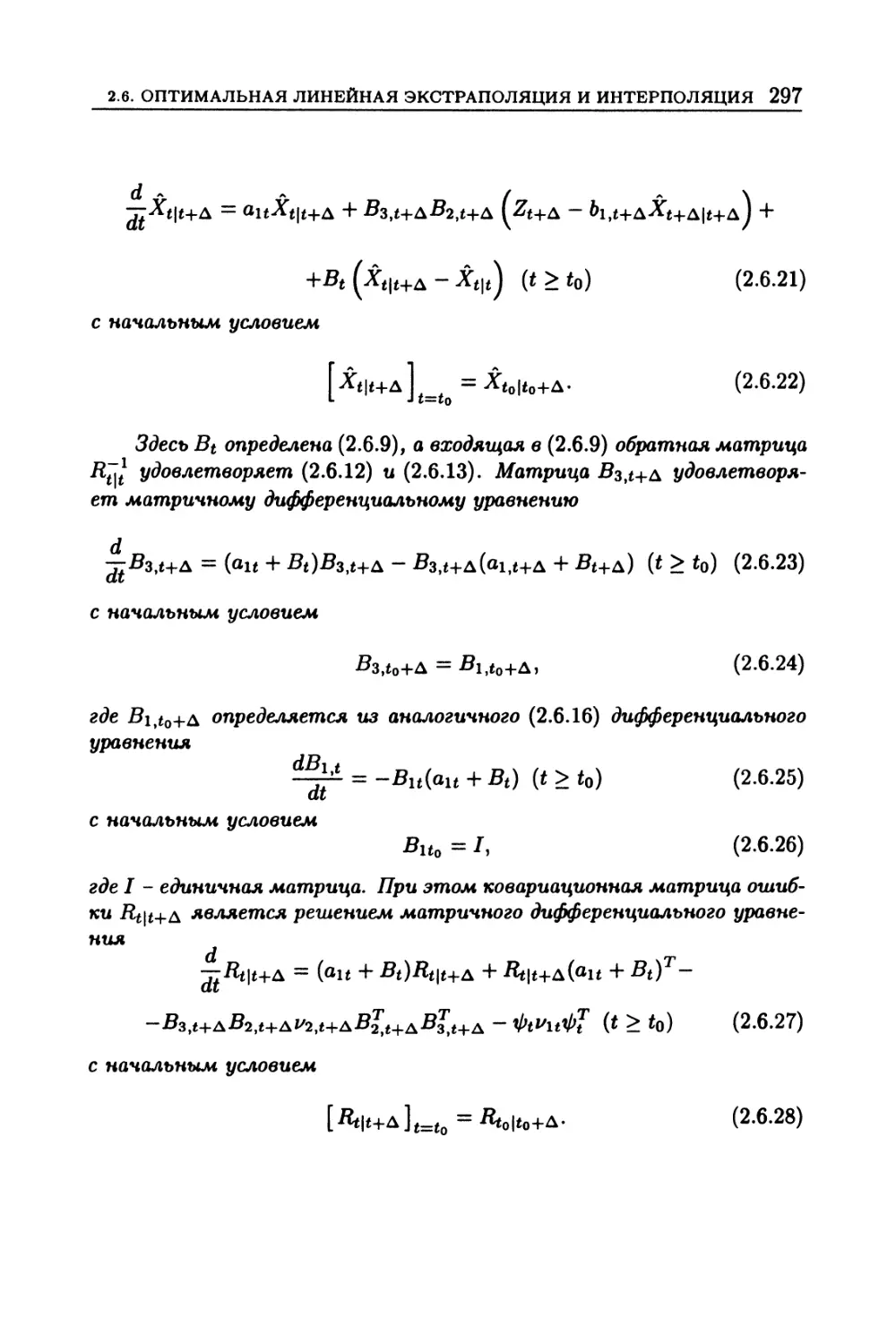

2.6. Оптимальная линейная экстраполяция и интерполяция ... 290

2.6.1. Оптимальная линейная экстраполяция (290). 2.6.2. Оптимальная интерпо-

ляция (294).

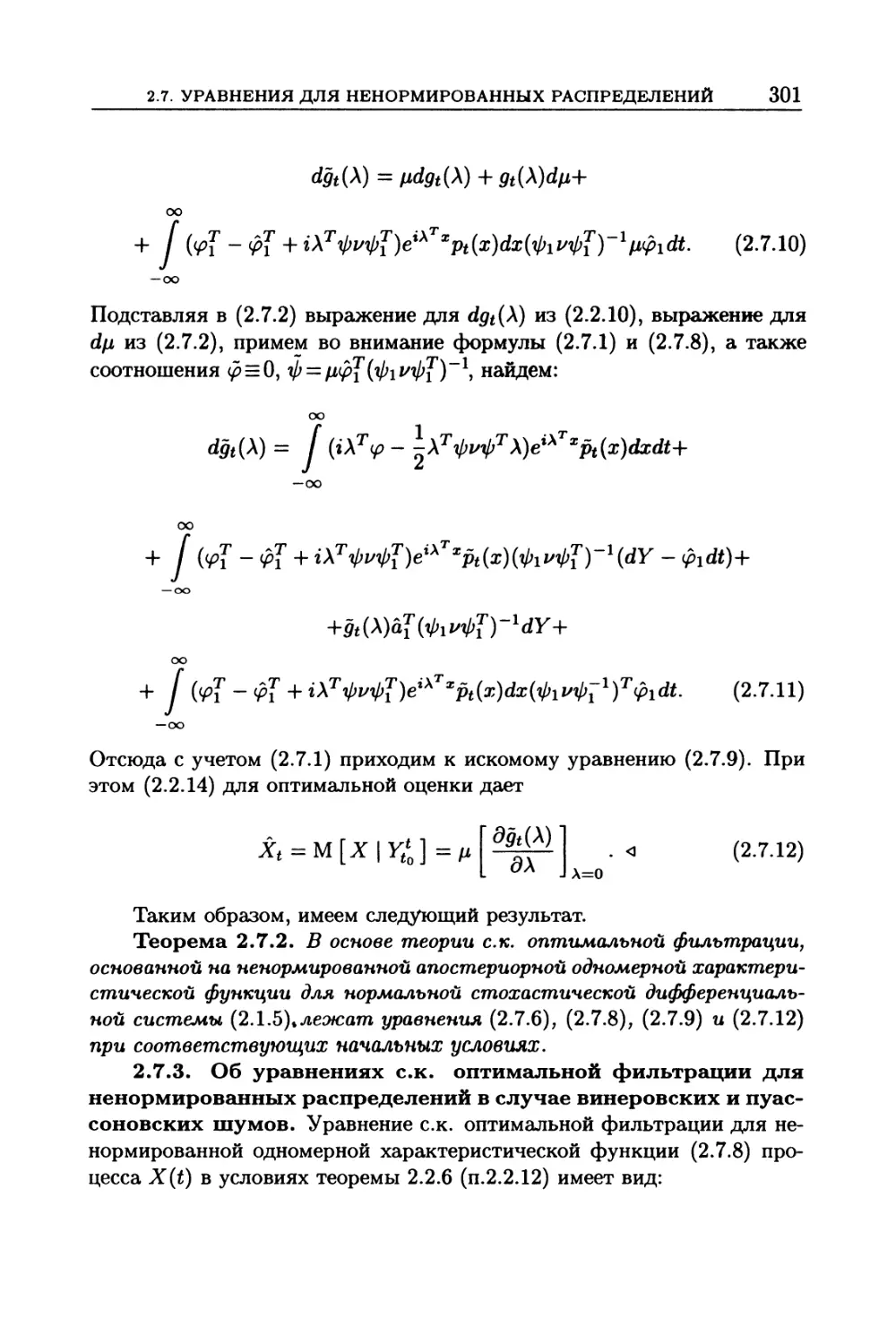

2.7. Фильтрационные уравнения для ненормированных

распределений в стохастических дифференциальных

системах.......................................................... 298

2.7.1. Уравнения ненормированной одномерной плотности (298). 2.7.2. Уравнение

для ненормированной характеристической функции (300). 2.7.3. Об уравнениях

с.к. оптимальной фильтрации для ненормированных распределений в случае ви-

неровских и пуассоновских шумов (301).

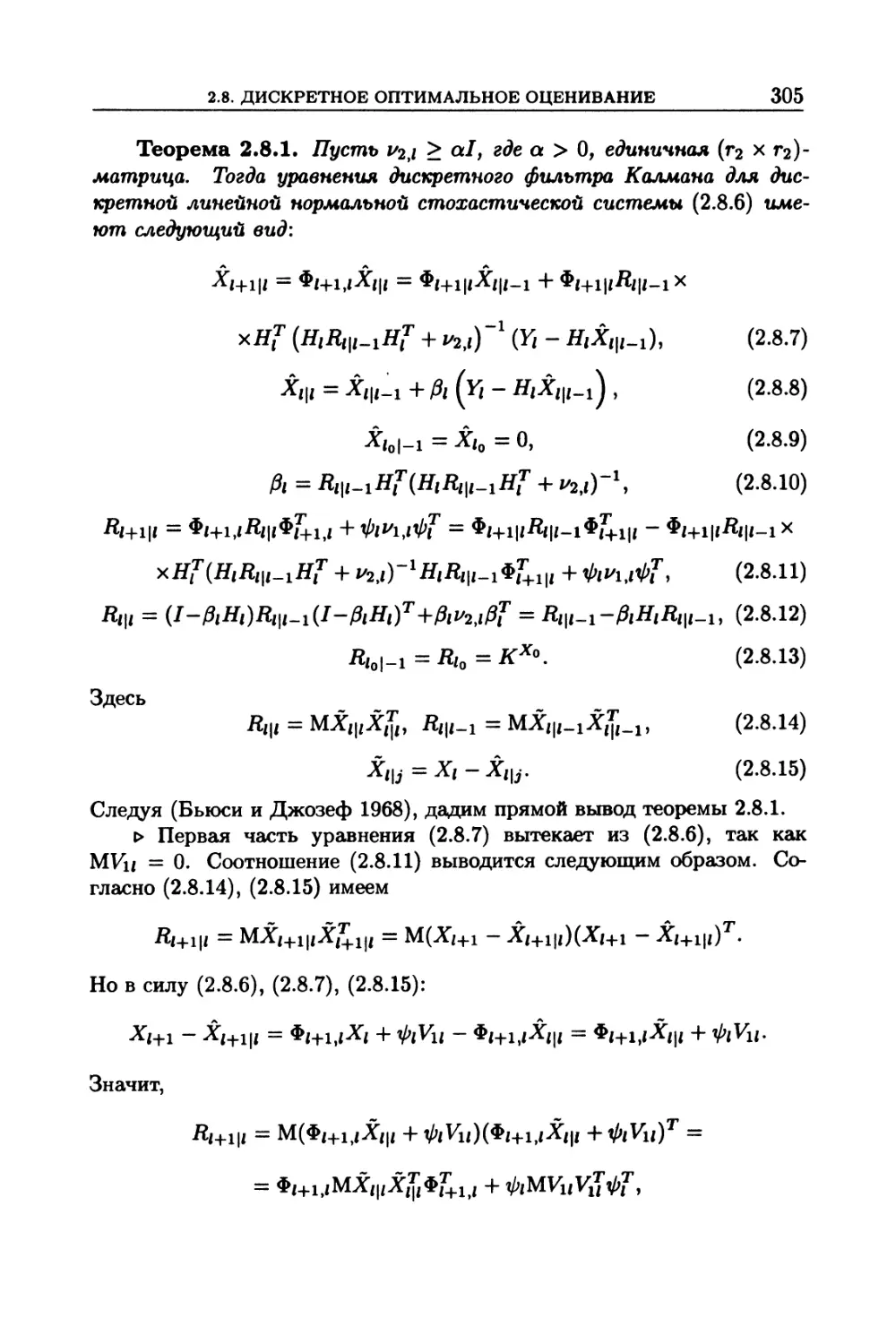

2.8. Дискретное оптимальное оценивание ........................... 302

2.8.1. Задача дискретного оценивания (302). 2.8.2. Задача интерполяции в дис-

кретных стохастических системах (303). 2.8.3. Дискретная оптимальная филь-

трация (304). 2.8.4. Дискретная с.к. оптимальная линейная фильтрация (304).

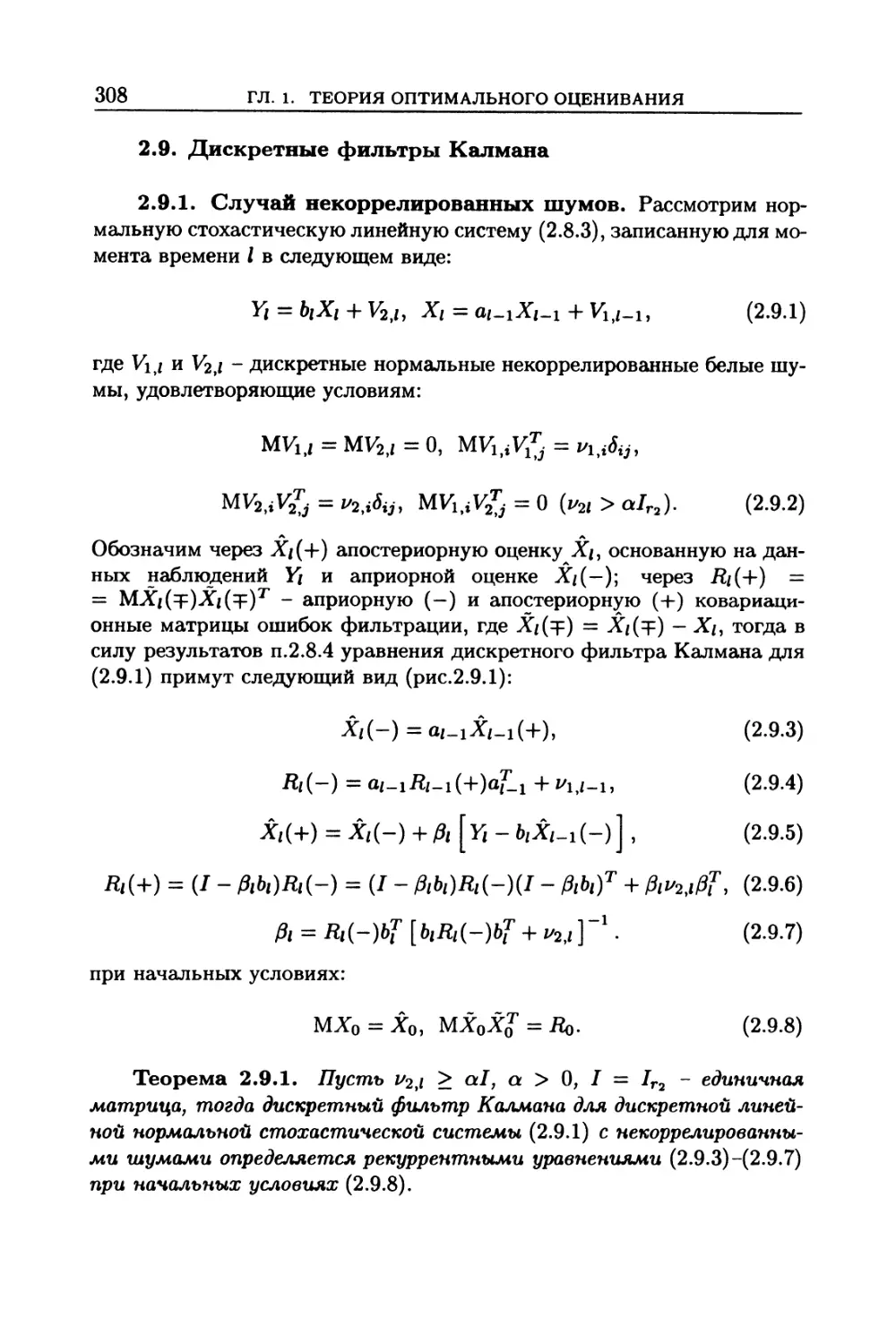

2.9. Дискретные фильтры Калмана................................... 308

2.9.1. Случай некоррелированных шумов (308). 2.9.2. Дискретный фильтр Кал-

мана для коррелированных шумов (313). 2.9.3. Дискретный фильтр Калмана для

автокоррелированных шумов в наблюдениях (314). 2.9.4. Дискретный фильтр

Калмана при линейных преобразованиях (314). 2.9.5. Связь между непрерывны-

ми и дискретными фильтрами Калмана (315).

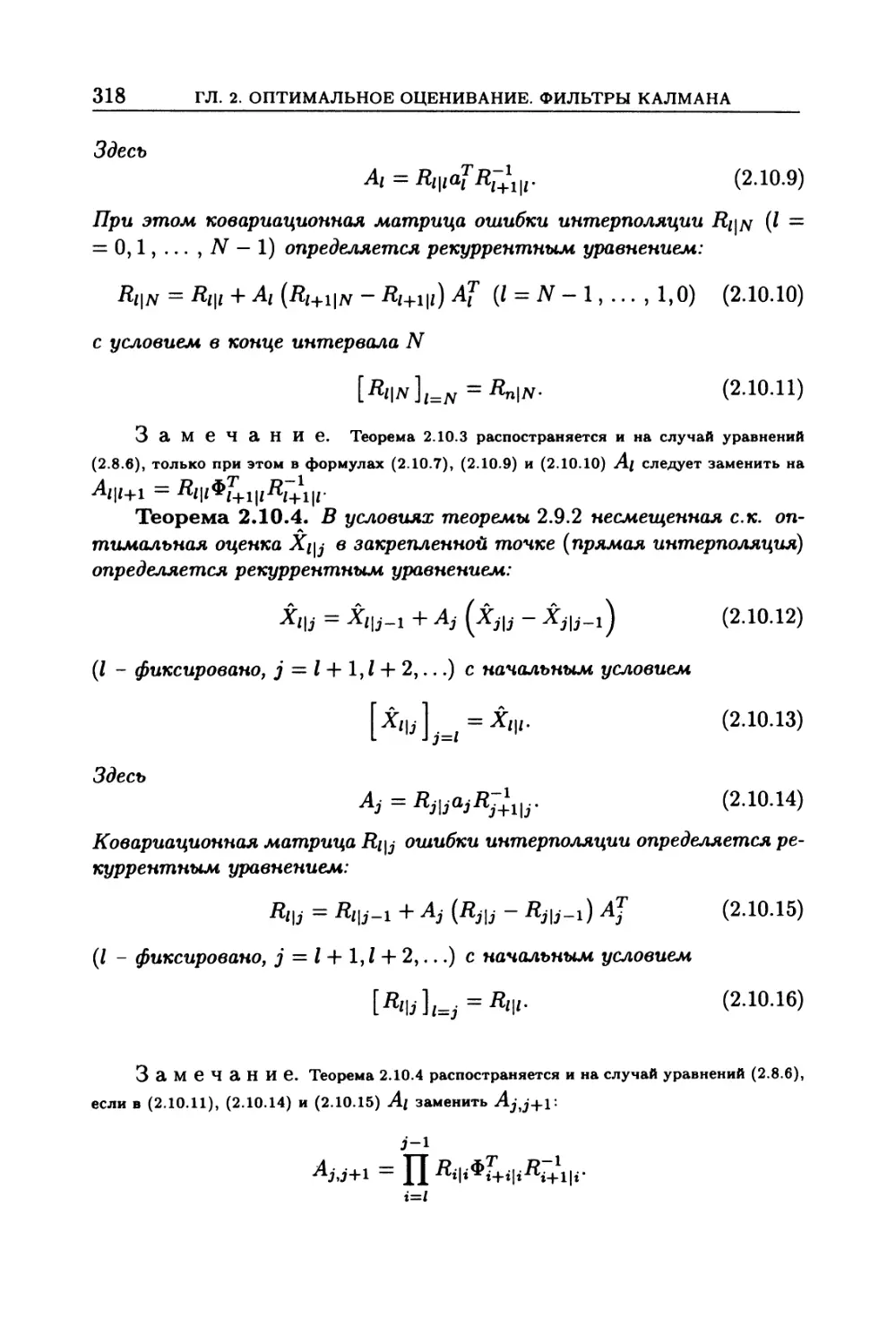

2.10. Дискретные линейные оптимальные экстраполяторы

и интерполяторы................................................... 316

2.10.1. Дискретные линейные экстраполяторы (316). 2.10.2. Дискретные линейные

интерполяторы (317).

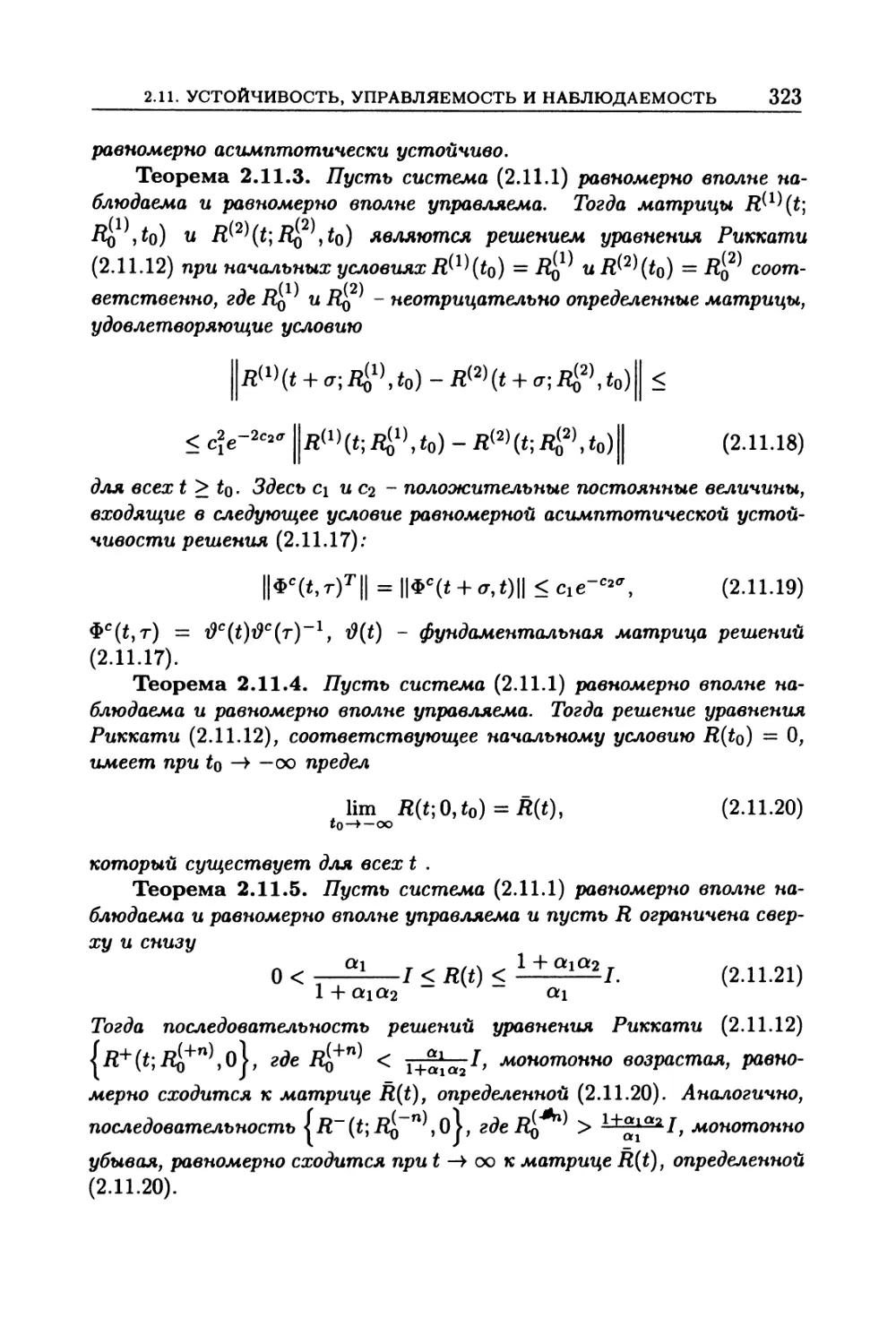

2.11. Устойчивость, управляемость и наблюдаемость

стохастических систем и фильтры Калмана .......................... 320

2.11.1. Вспомогательные утверждения (320). 2.11.2. Основные теоремы (322).

2.11.3. Линейные стохастические дифференциальные системы с автокоррелиро-

ванными помехами в наблюдениях (325). 2.11.4. Дискретные линейные стохасти-

ческие системы (326).

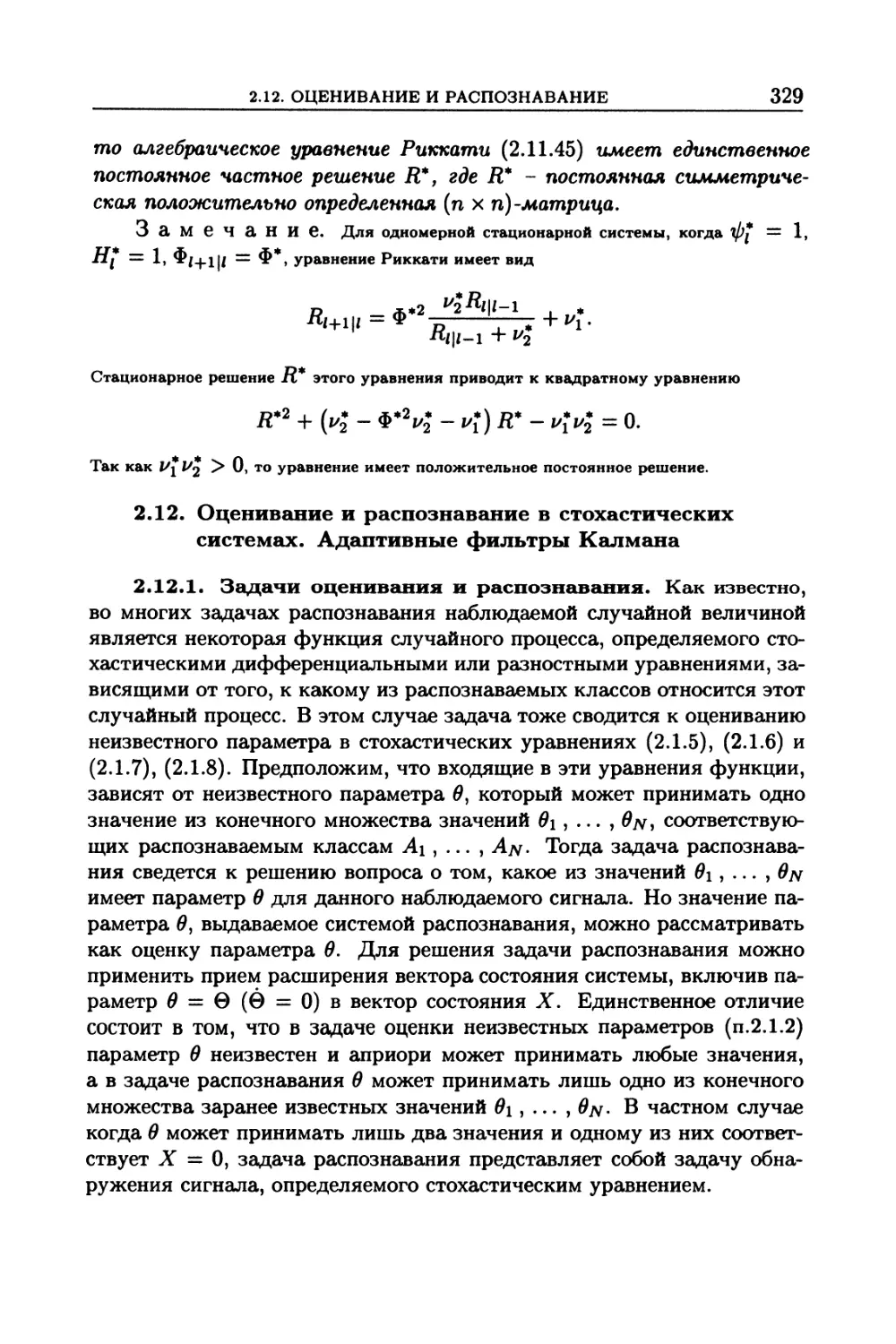

2.12. Оценивание и распознавание в стохастических

системах. Адаптивные фильтры Калмана ............................. 329

6

Оглавление

2.12.1. Задачи оценивания и распознавания (329). 2.12.2. Стохастические диффе-

ренциалы апостериорных вероятностей в задаче распознавания (330). 2.12.3. Оп-

тимальное распознавание в линейных системах (333). 2.12.4. Оптимальное рас-

познавание в случае уравнений, линейных относительно вектора состояния (335).

2.12.5. Адаптивное дискретное оценивание. Адаптивные фильтры Калмана-

Лайниотиса (336).

2.13. Дополнения и задачи ................................. 338

Г л а в а 3. Субоптимальное оценивание.

Обобщенные фильтры Калмана................................. 371

3.1. Субоптимальное оценивание. Метод нормальной аппроксимации 371

3.1.1. Общая характеристика приближенных методов оптимального оценивания

(371). 3.1.2. Метод нормальной аппроксимации апостериорного распределения

(373).

3.2. Методы моментов и семиинвариантов для приближенного

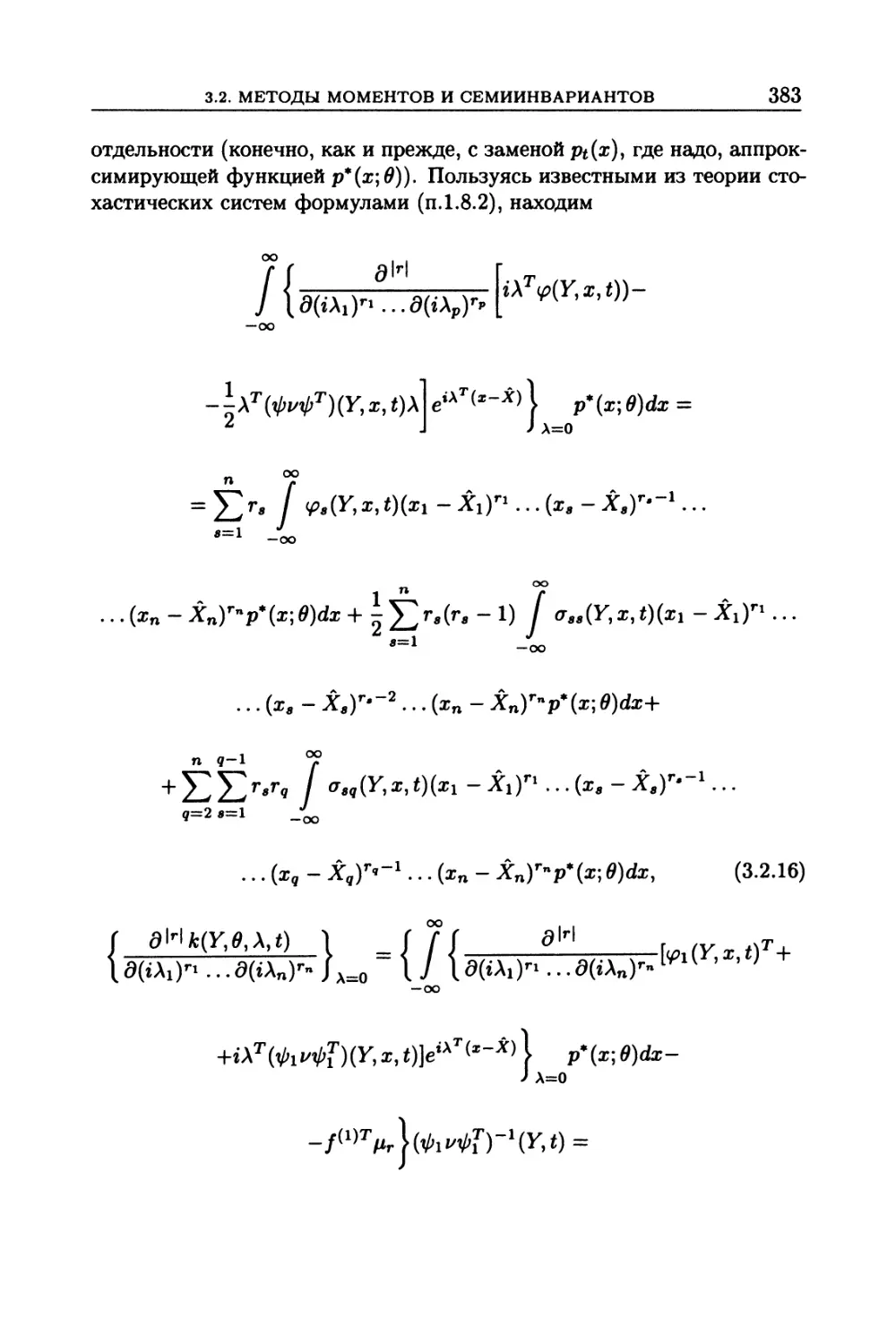

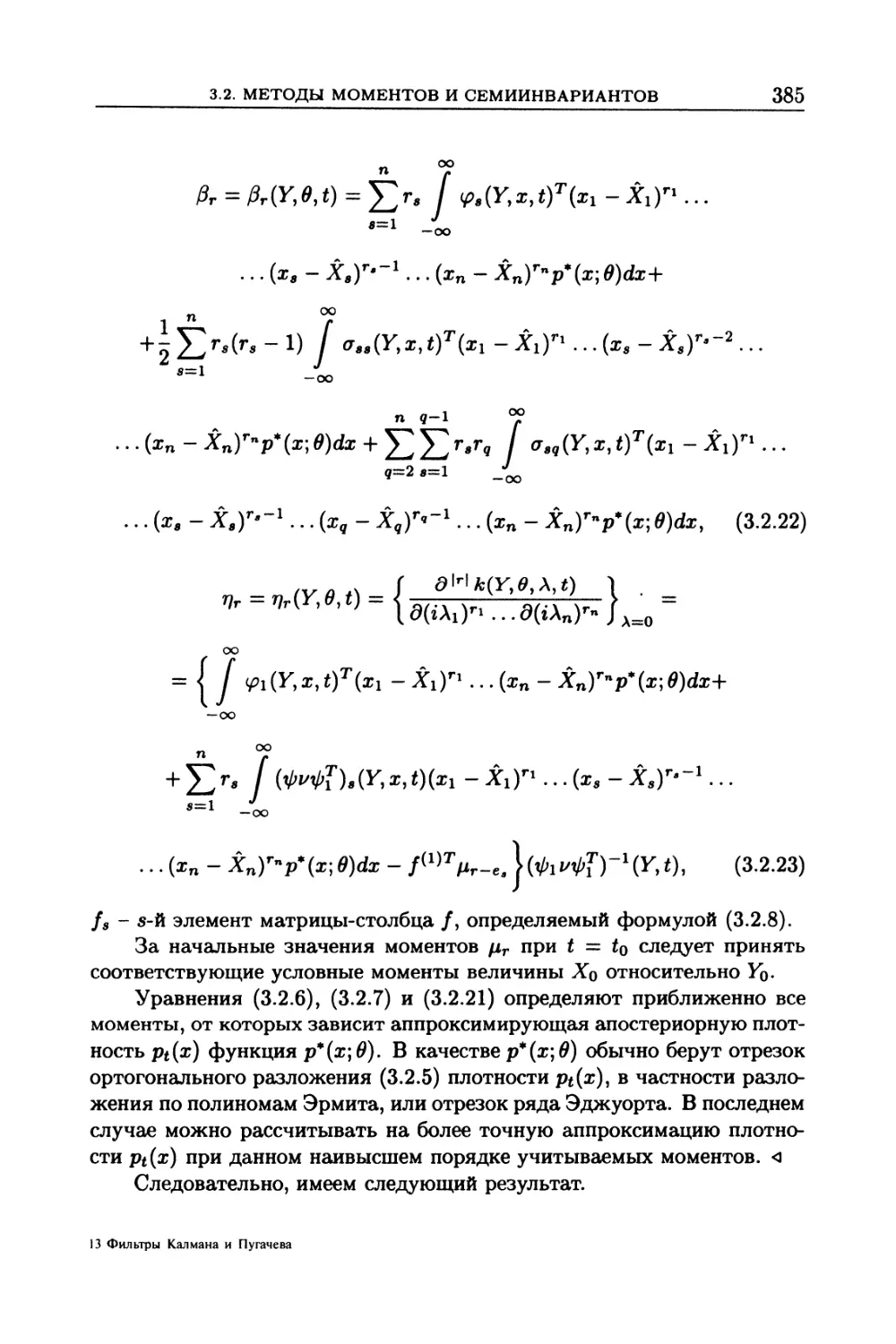

решения фильтрационных уравнений.............................. 378

3.2.1. Метод моментов. Начальные моменты (378). 3.2.2. Метод моментов. Цен-

тральные моменты (381). 3.2.3. Метод семиинвариантов (387).

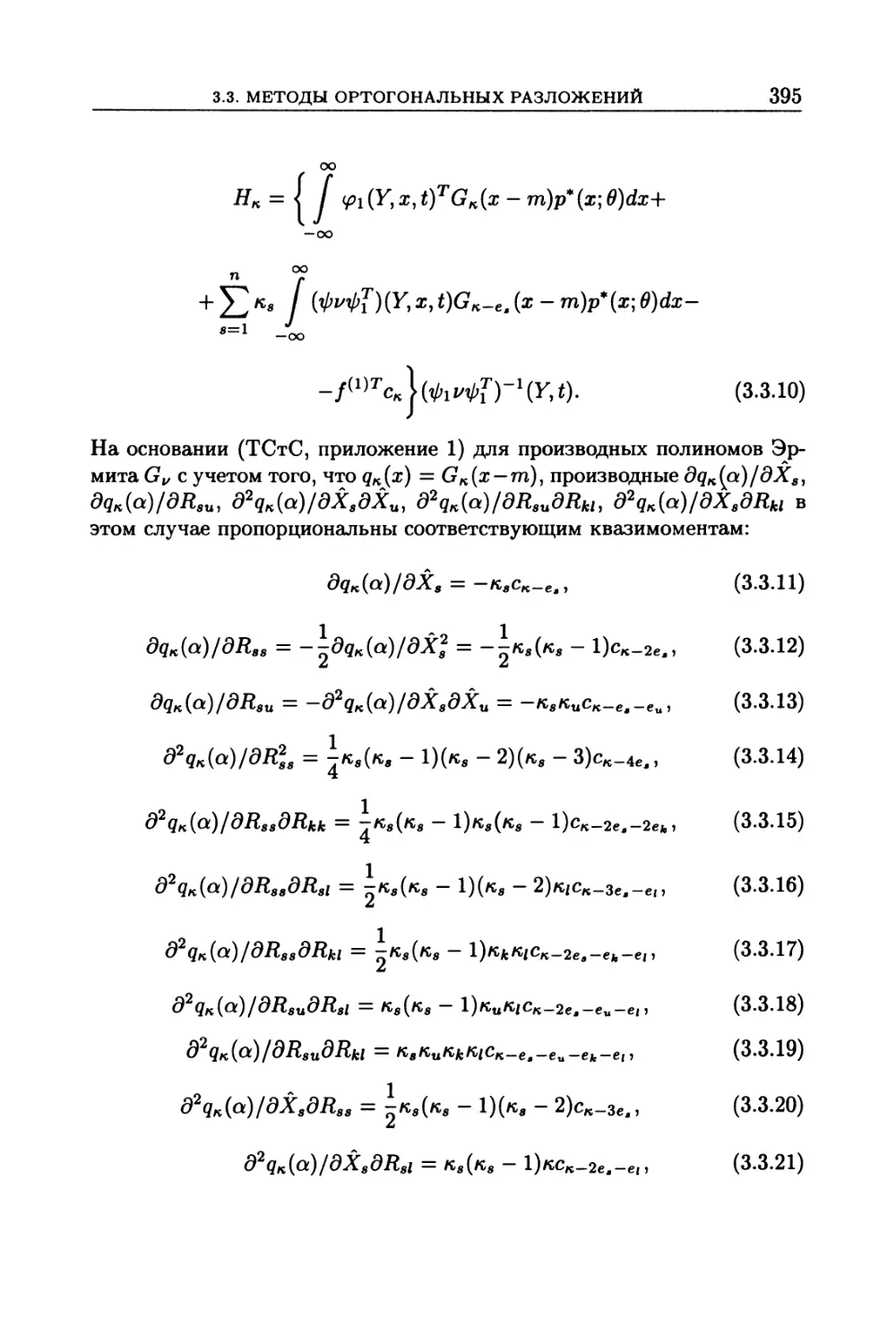

3.3. Методы ортогональных разложений и квазимоментов

для приближенного решения фильтрационных уравнений ........... 391

3.3.1. Метод ортогональных разложений (391). 3.3.2. Метод квазимоментов (394).

3.3.3. Сокращение числа уравнений (396).

3.4. Уравнения субоптимальной фильтрации для ненормированных

распределений ................................................ 397

3.4.1. Модифицированный метод нормальной аппроксимации (397). 3.4.2. Моди-

фицированный метод моментов (402). 3.4.3. Модифицированный метод ортого-

нальных разложений (404).

3.5. Методы, основанные на упрощении фильтрационных

уравнений .................................................... 409

3.5.1. Способы упрощения уравнений оптимальной фильтрации (409). 3.5.2. Обоб-

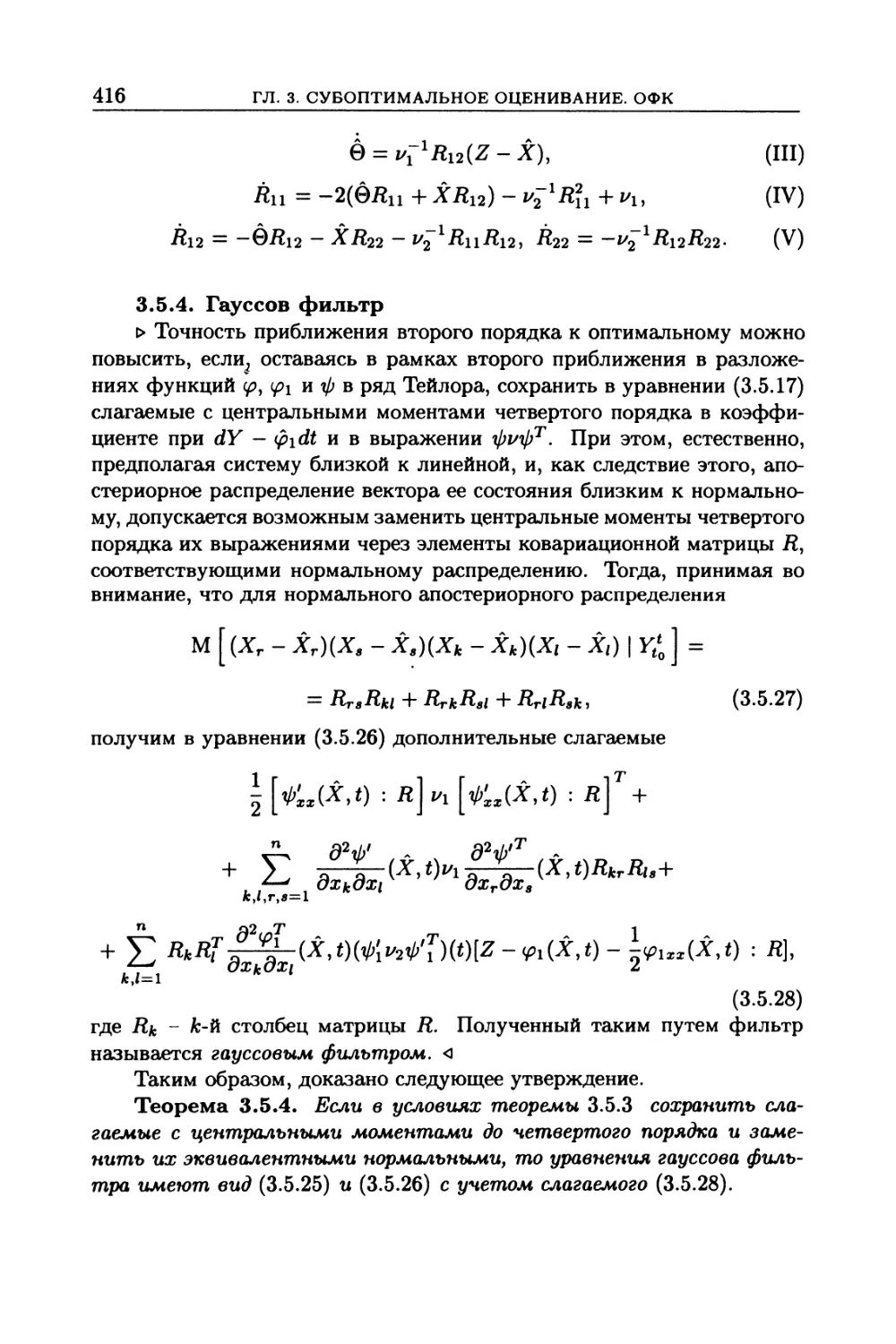

щенный фильтр Калмана-Быоси (409). 3.5.3. Фильтры второго порядка (412).

3.5.4. Гауссов фильтр (416). 3.5.5. Априорная оценка точности фильтрации (417).

3.6. Дискретное субоптимальное с.к. оценивание и

распознавание. Адаптивные обобщенные фильтры Калмана .... 418

3.6.1. Дискретное субоптимальное оценивание и распознавание (418). 3.6.2. Суб-

оптимальное адаптивное оценивание (419). 3.6.3. Дискретный субоптимальный

адаптивный фильтр на основе МНА (419). 3.6.4. Дискретный субоптимальный

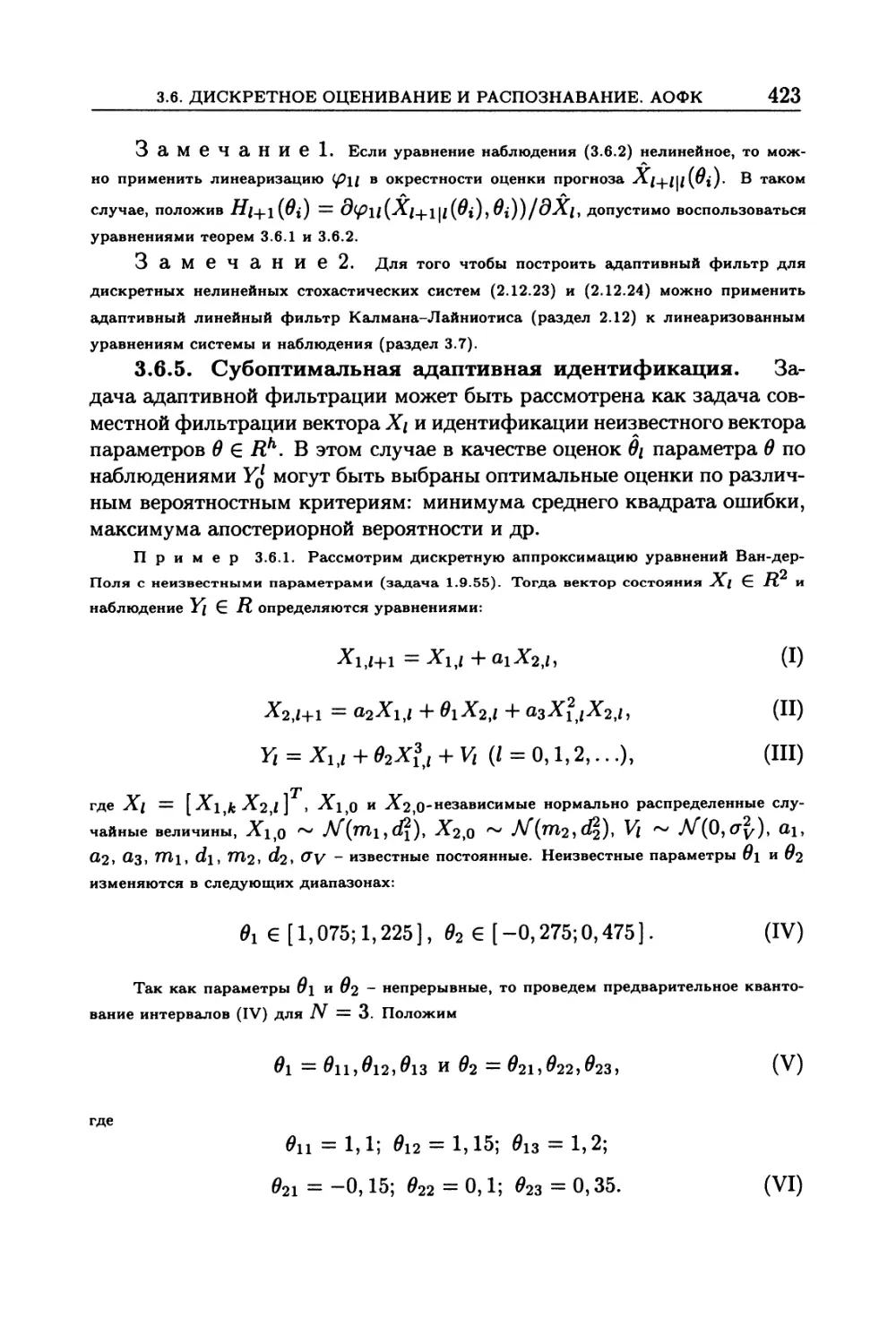

адаптивный фильтр на основе ОФК (422). 3.6.5. Субоптимальная адаптивная

идентификация (423). 3.6.6. Адаптивное распознавание (426).

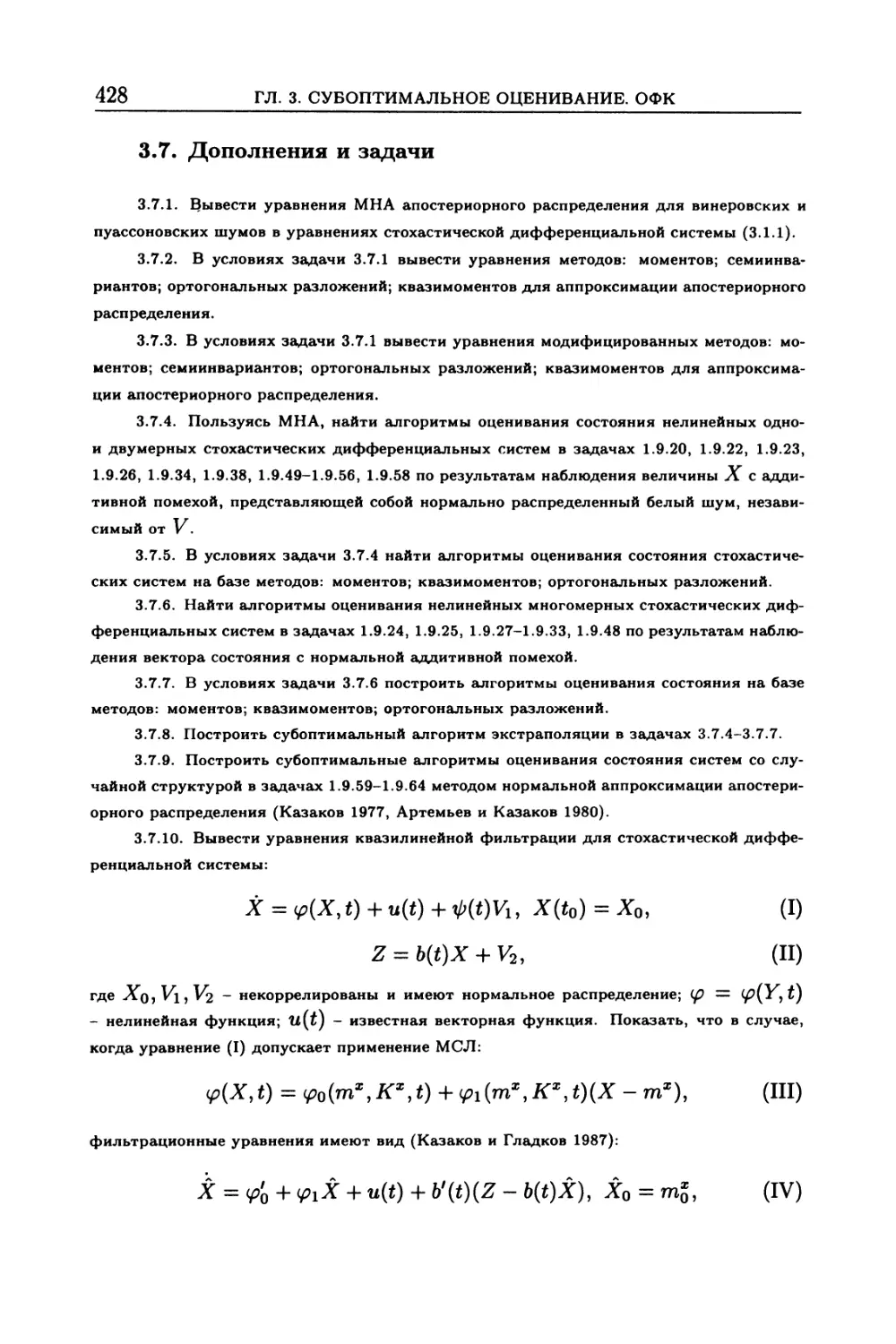

3.7. Дополнения и задачи ...................................... 428

Оглавление

7

Г л а в а 4. Условно оптимальное оценивание.

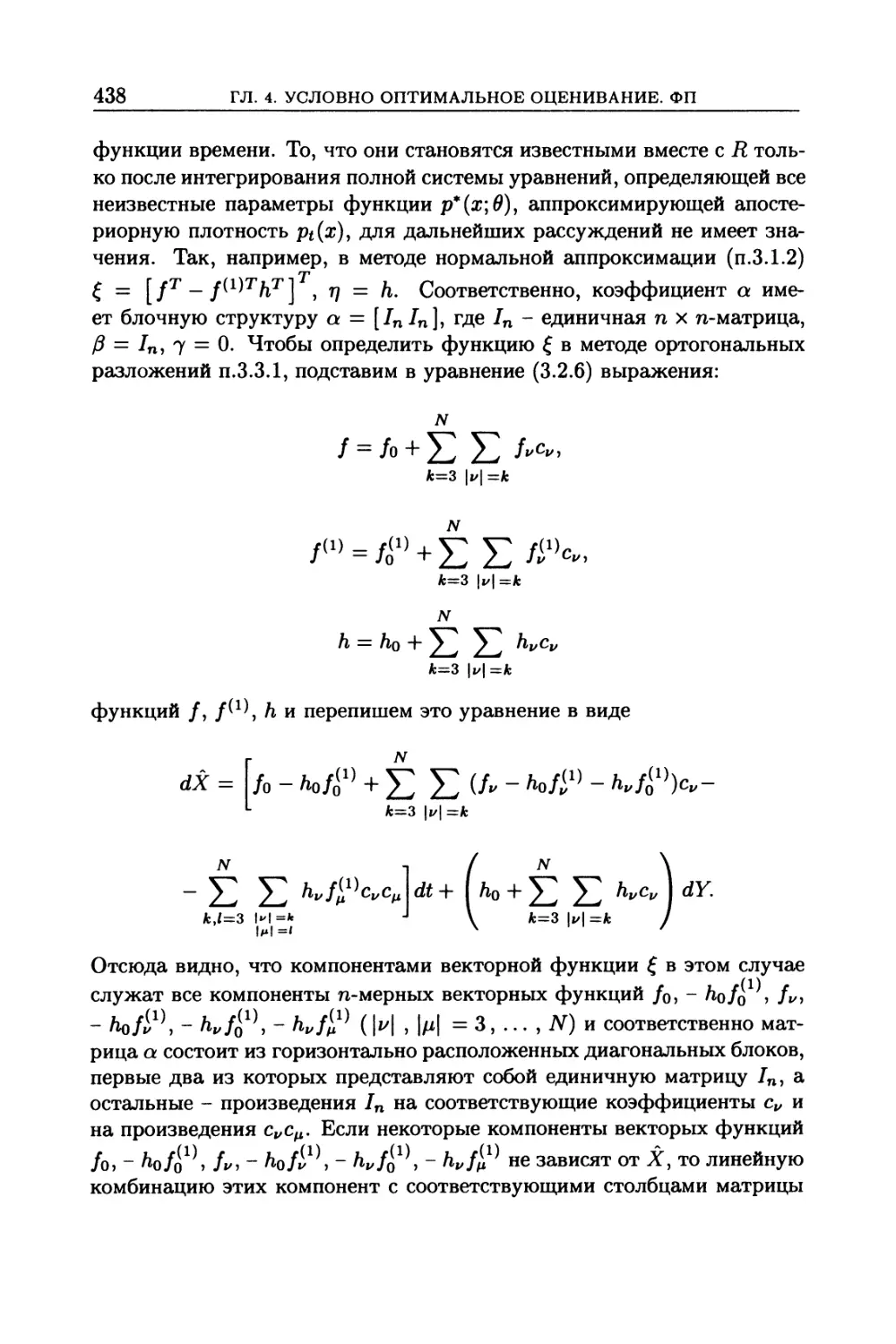

Фильтры Пугачева .................................. 437

4.1. Задачи условно оптимального оценивания в стохастических

дифференциальных системах......................... 437

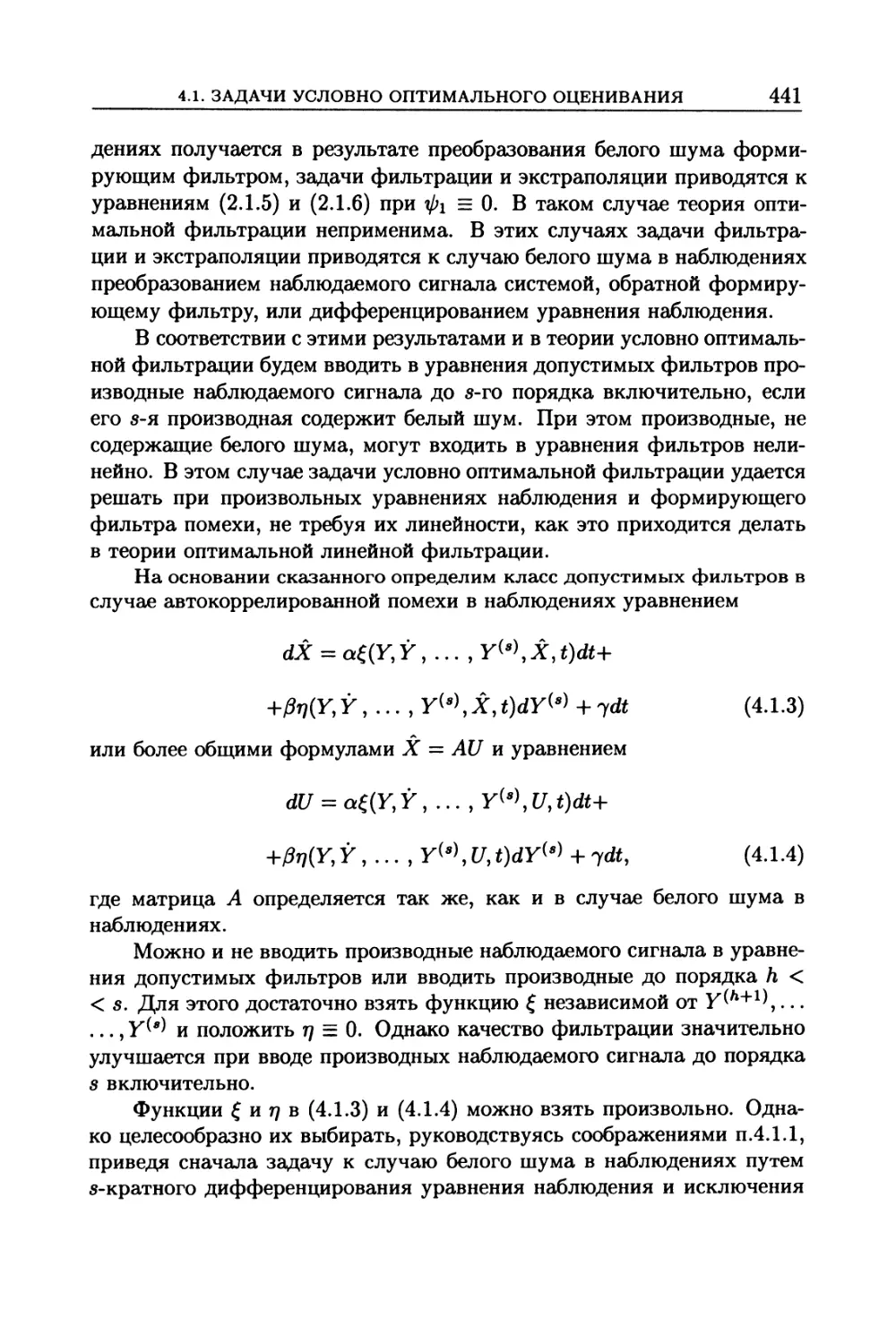

4.1.1. Основная идея условно оптимальной фильтрации (437). 4.1.2. Классы допу-

стимых фильтров (439). 4.1.3. Классы допустимых фильтров при автокоррелиро-

ванной помехе в наблюдениях (440). 4.1.4. Постановка задач условно оптимальной

фильтрации и экстраполяции (442).

4.2. Решение задач условно оптимальной фильтрации ................ 446

4.2.1. Определение коэффициентов уравнения условно оптимального фильтра

(446). 4.2.2. Случай винеровского процесса и линейного фильтра (449). 4.2.3. Слу-

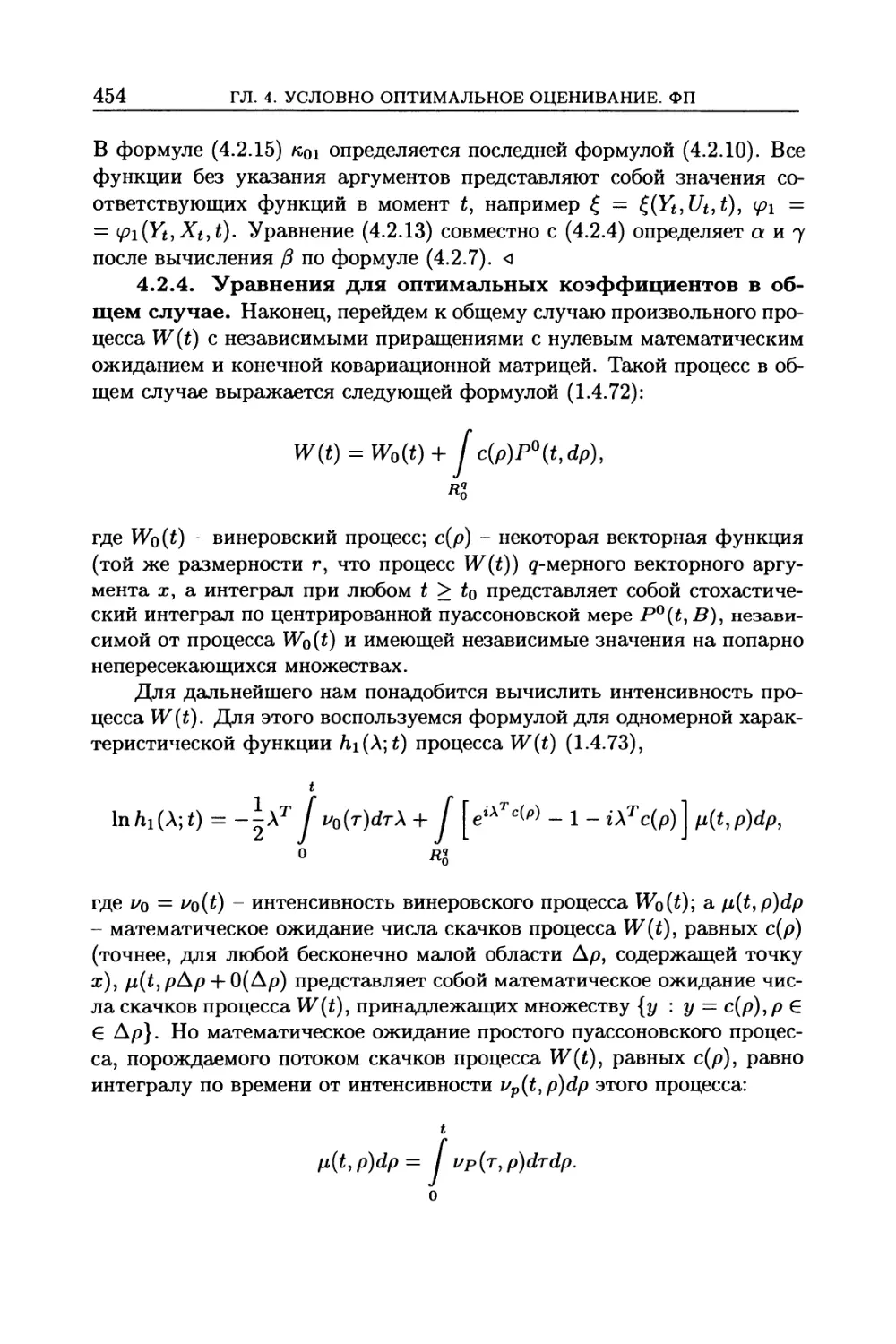

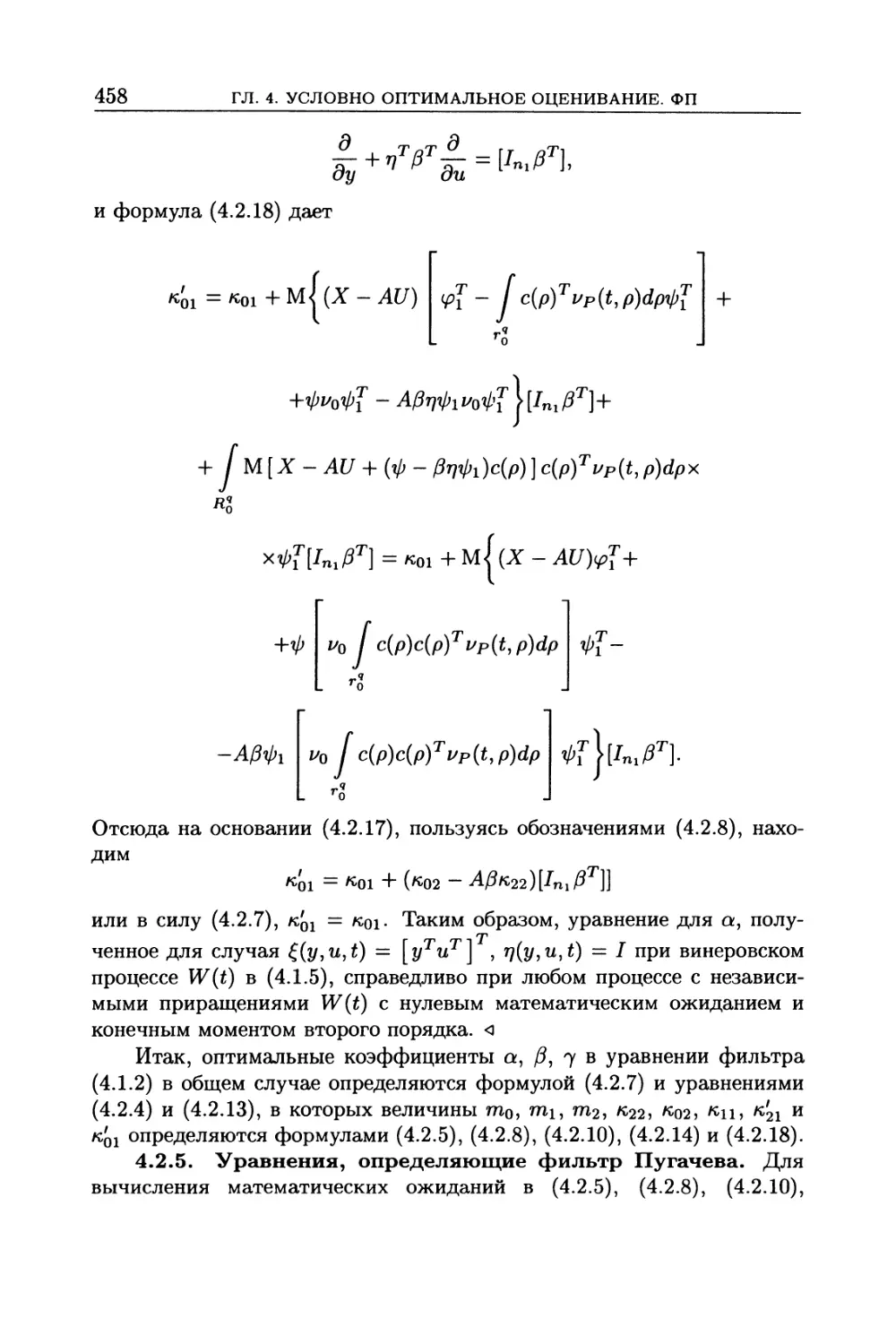

чай винеровского процесса и нелинейного фильтра (451). 4.2.4. Уравнения для

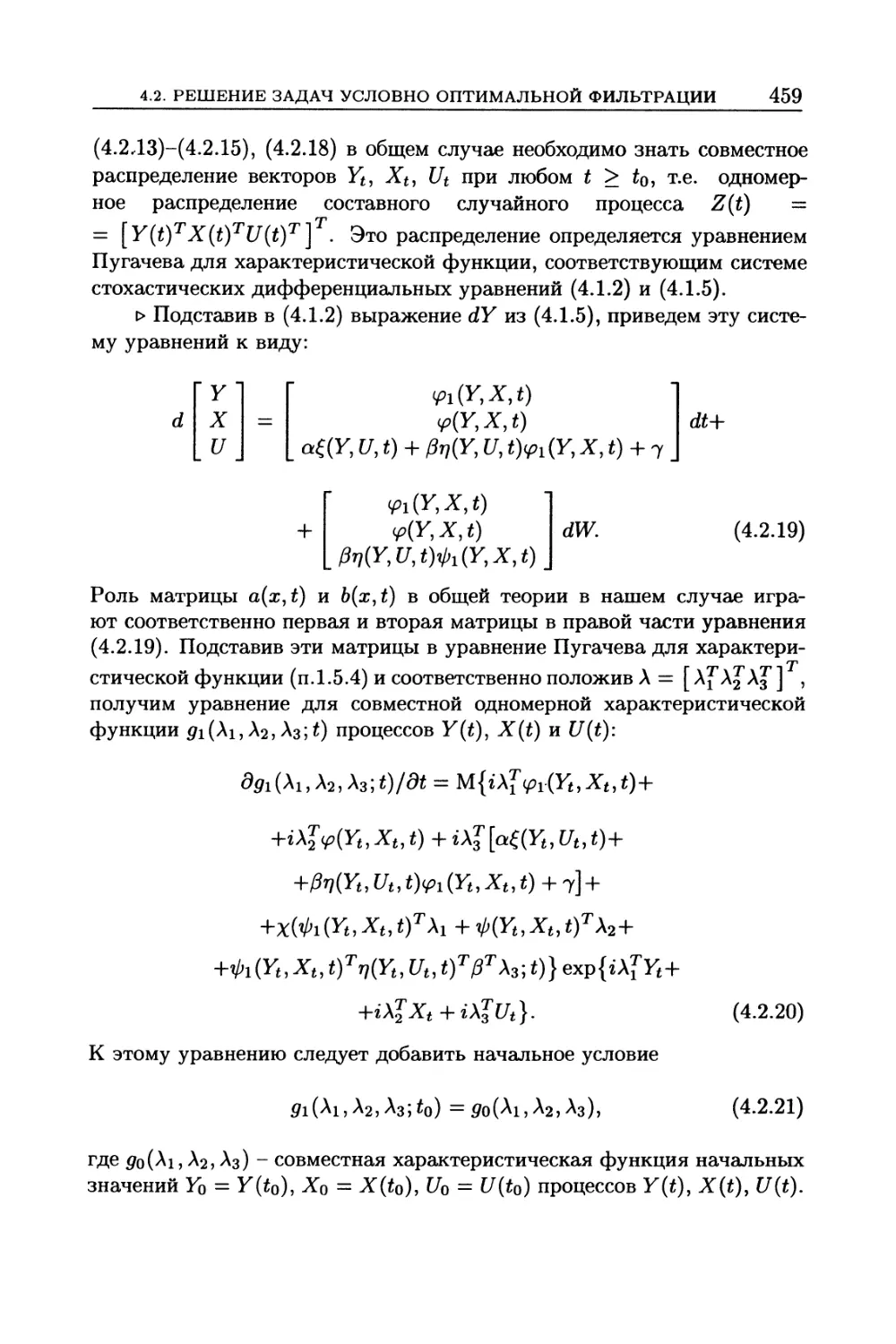

оптимальных коэффициентов в общем случае (454). 4.2.5. Уравнения, определя-

ющие фильтр Пугачева (458). 4.2.6. Формула для производной ковариационной

матрицы ошибки фильтров и экстраполяторов Пугачева (469). 4.2.7. Применение

условно оптимальной фильтрации к задачам распознавания (470).

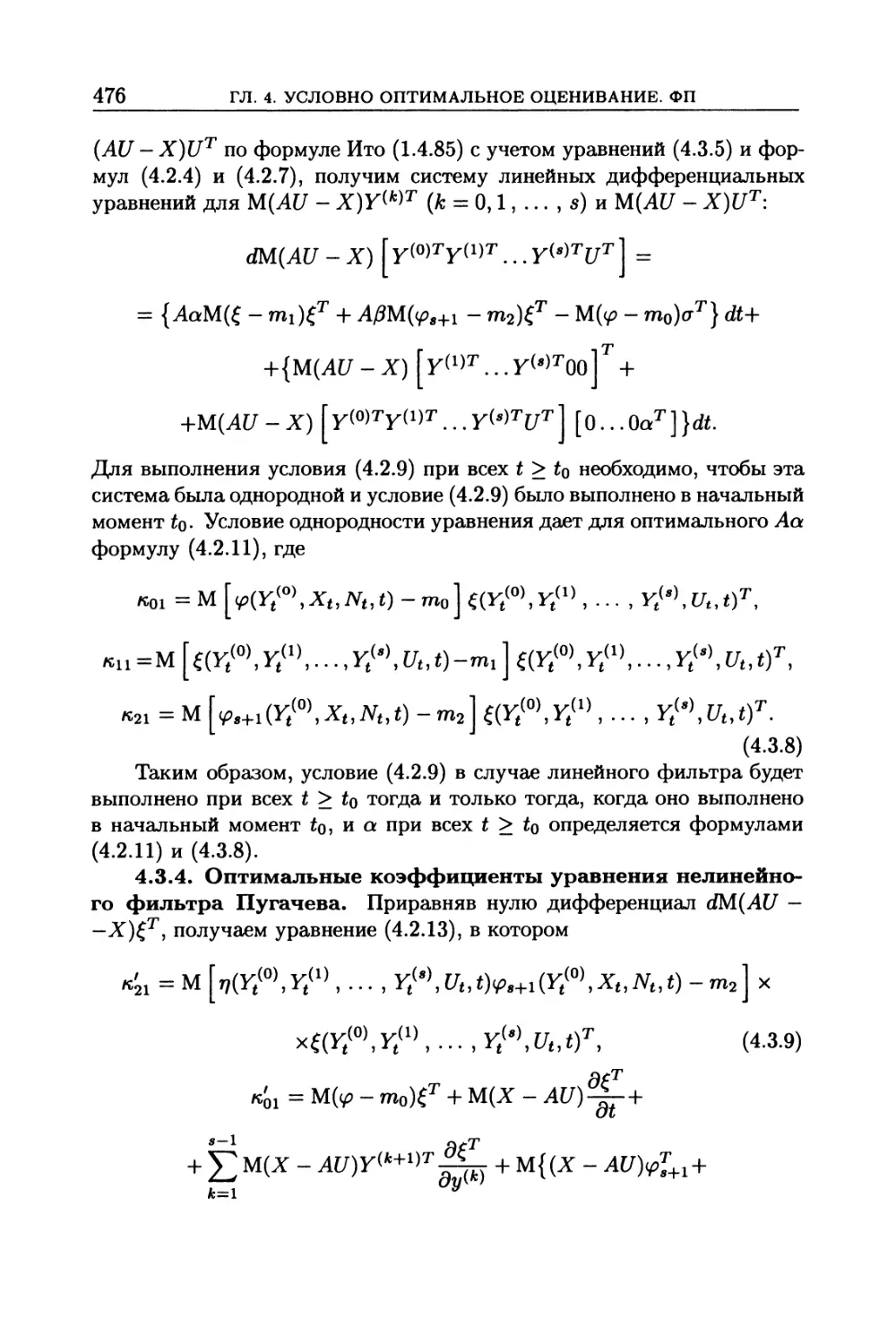

4.3. Фильтрация при автокоррелированной помехе в наблюдениях 471

4.3.1. Преобразование уравнений (471). 4.3.2. Определение коэффициентов урав-

нения фильтра Пугачева (474). 4.3.3. Оптимальные коэффициенты уравнения

линейного фильтра (475). 4.3.4. Оптимальные коэффициенты уравнения нелиней-

ного фильтра Пугачева (476). 4.3.5. Уравнения, определяющие фильтр Пугачева

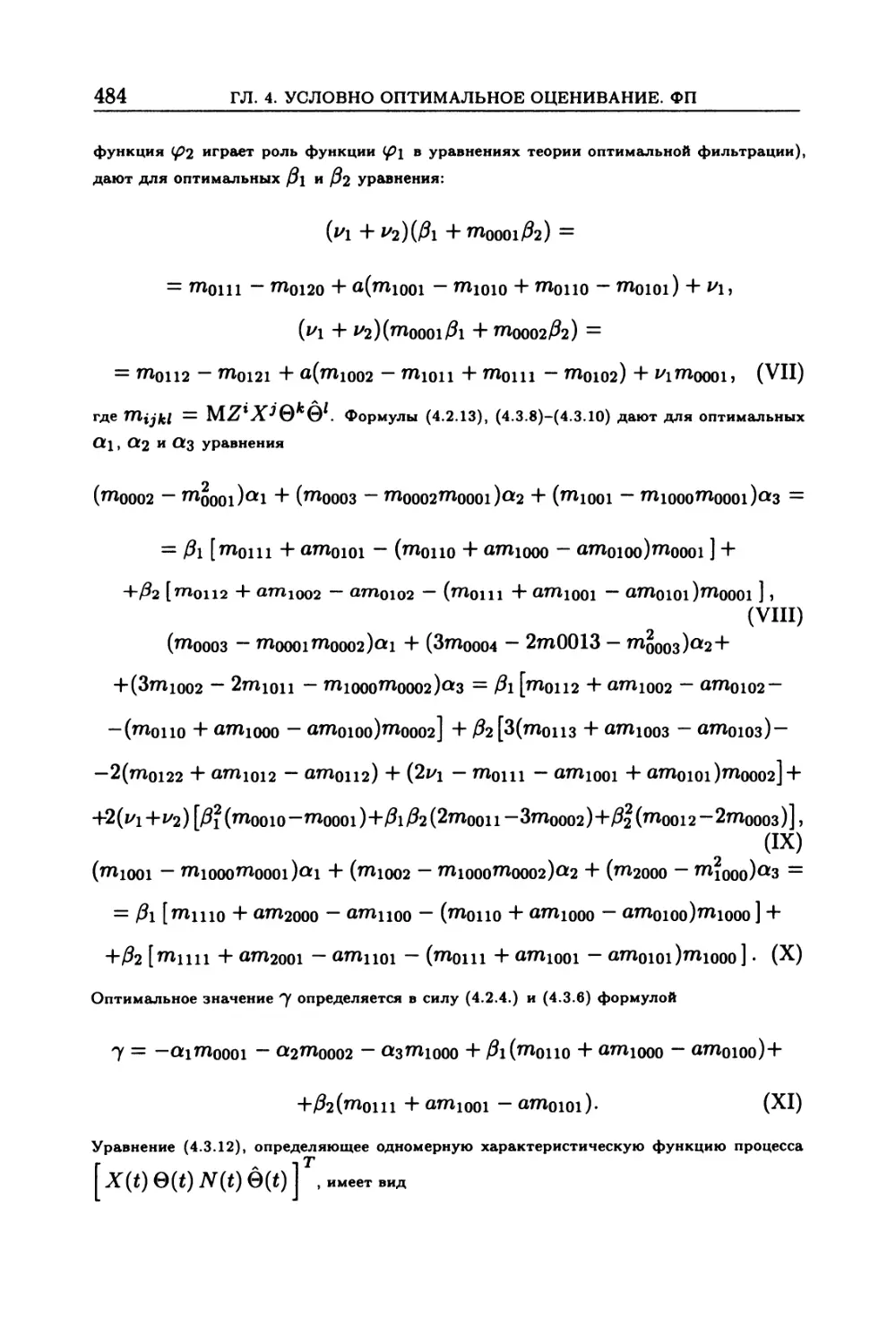

(477). 4.3.6. Формула для производной ковариационной матрицы ошибки (485).

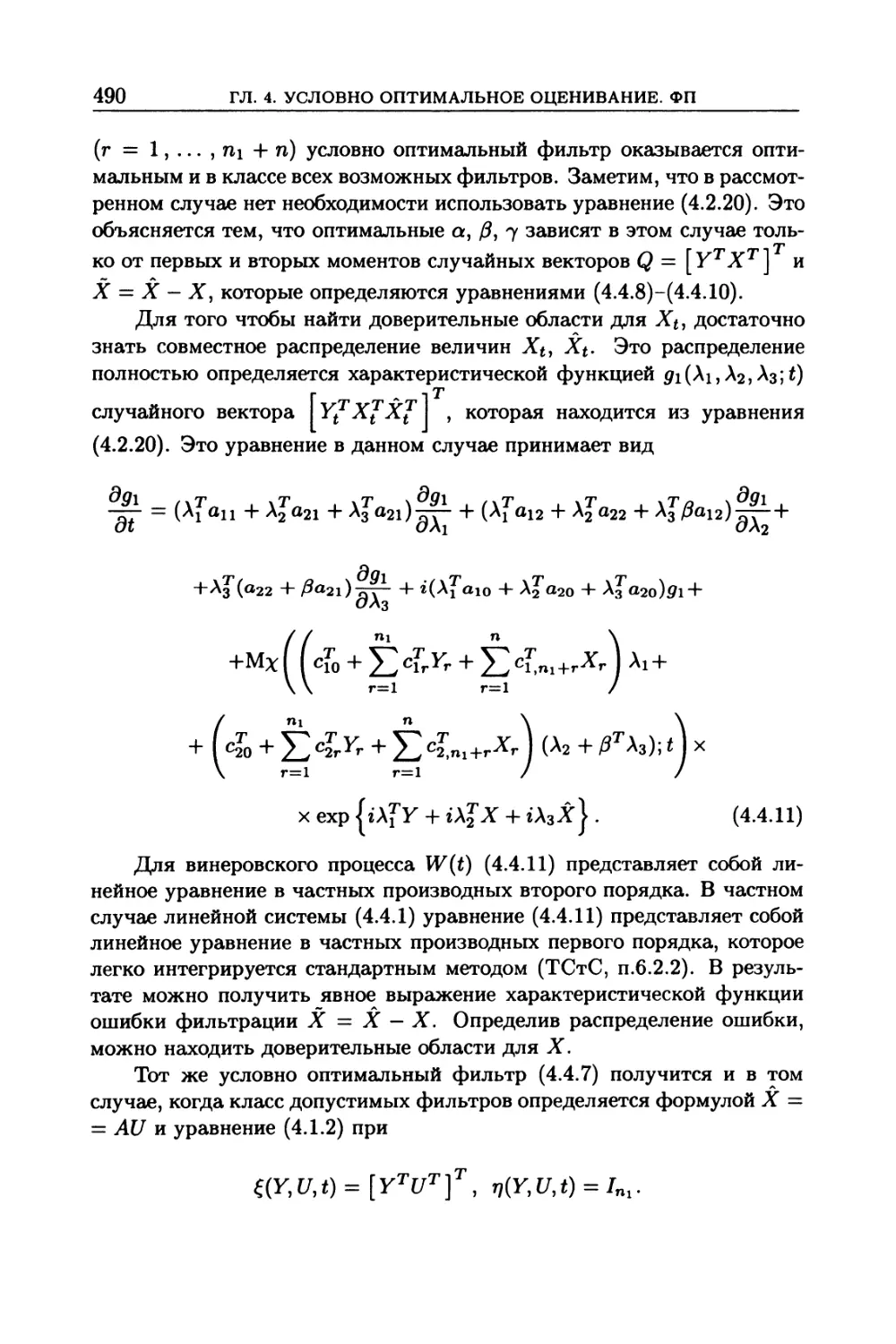

4.4. Условно оптимальная линейная фильтрация ..................... 486

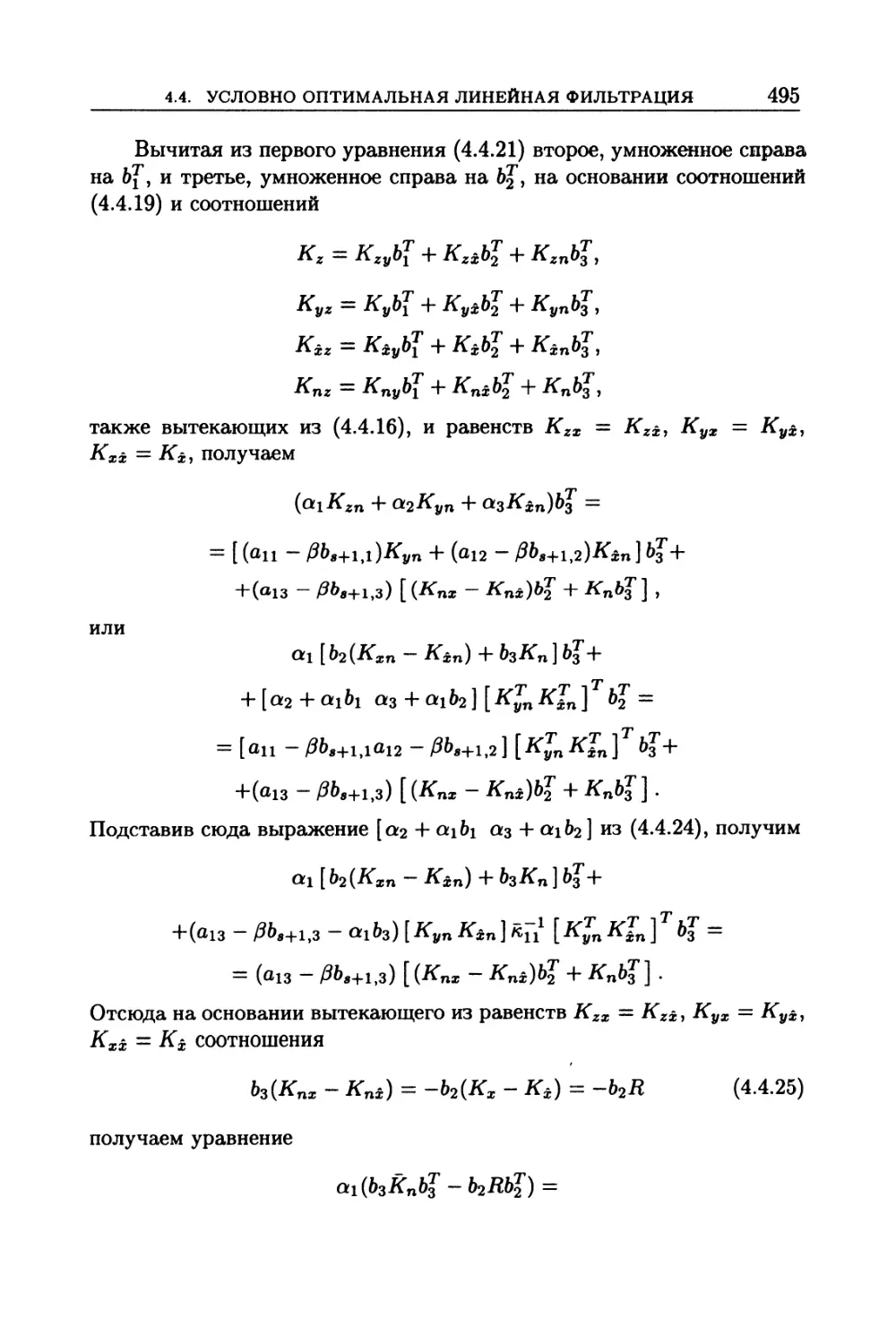

4.4.1. Фильтрация (486). 4.4.2. Фильтрация при автокоррелированной помехе

(492).

4.5. Условно оптимальная экстраполяция............................ 498

4.5.1. Постановка задач условно оптимальной экстраполяции (498). 4.5.2. Урав-

нения, определяющие условно оптимальный экстраполятор Пугачева (499). 4.5.3.

Уравнения, определяющие экстраполятор Пугачева при автокоррелированной по-

мехе в наблюдениях (504).

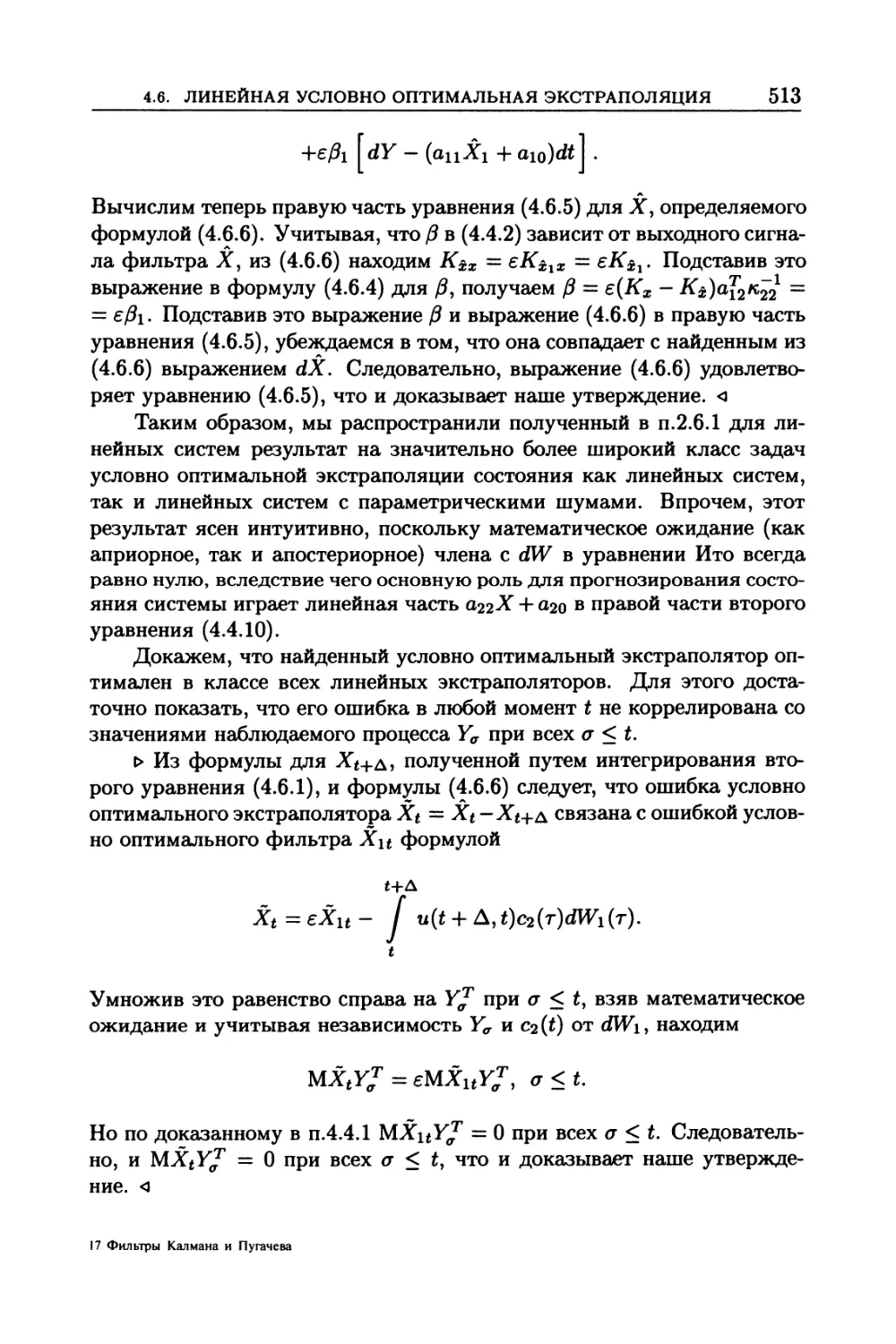

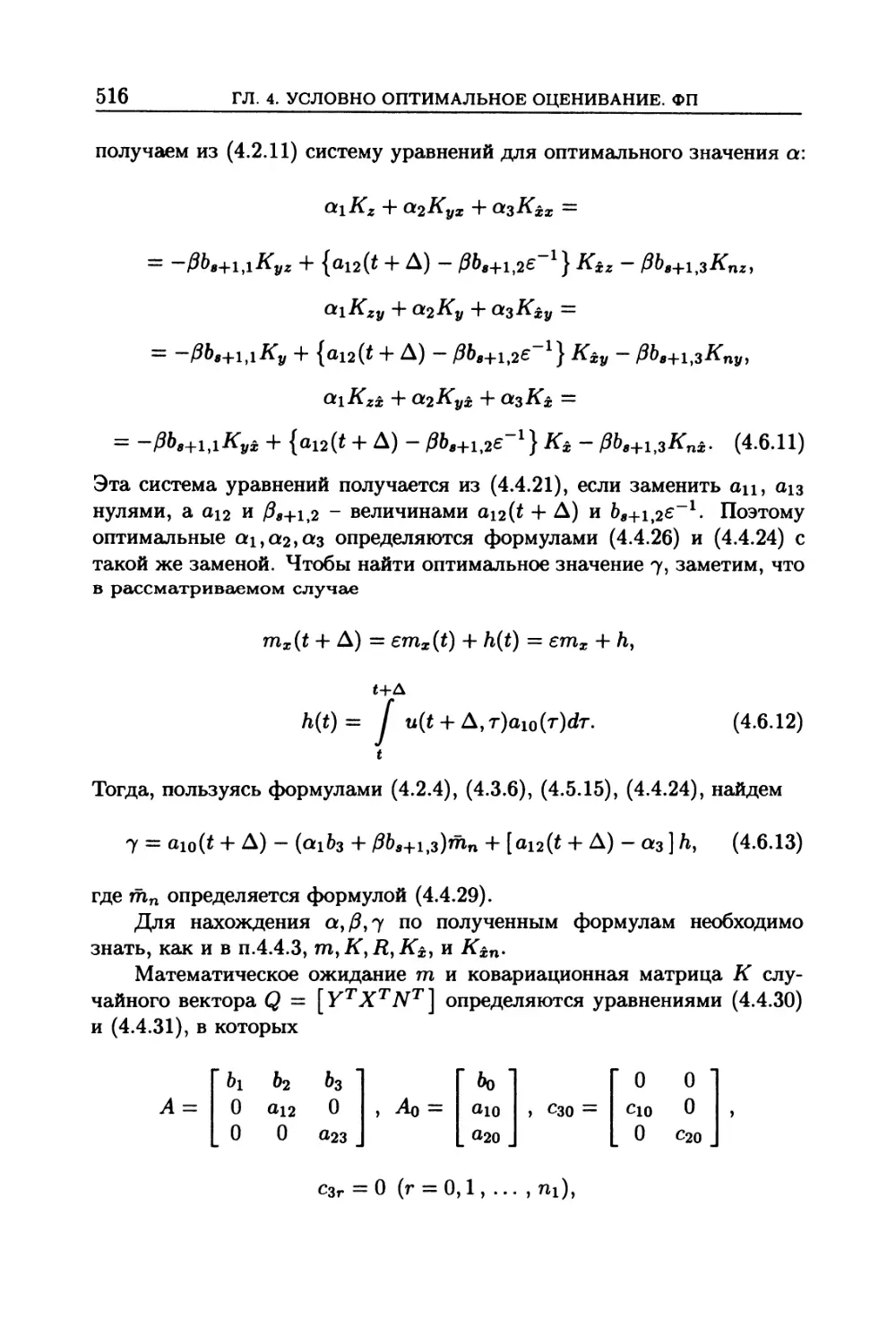

4.6. Линейная условно оптимальная экстраполяция...................... 509

4.6.1. Экстраполяция (509). 4.6.2. Экстраполяция при автокоррелированной по-

мехе (514).

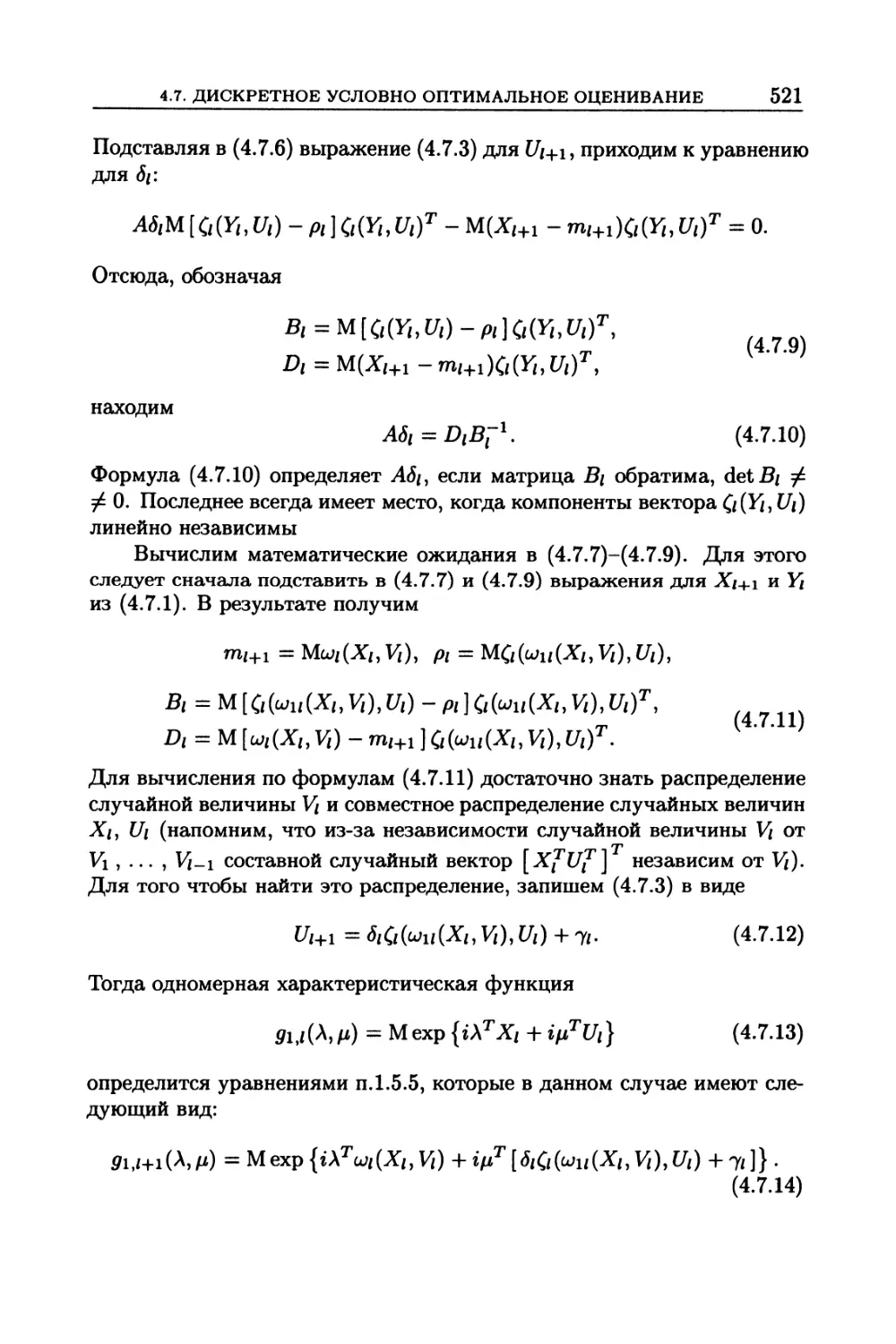

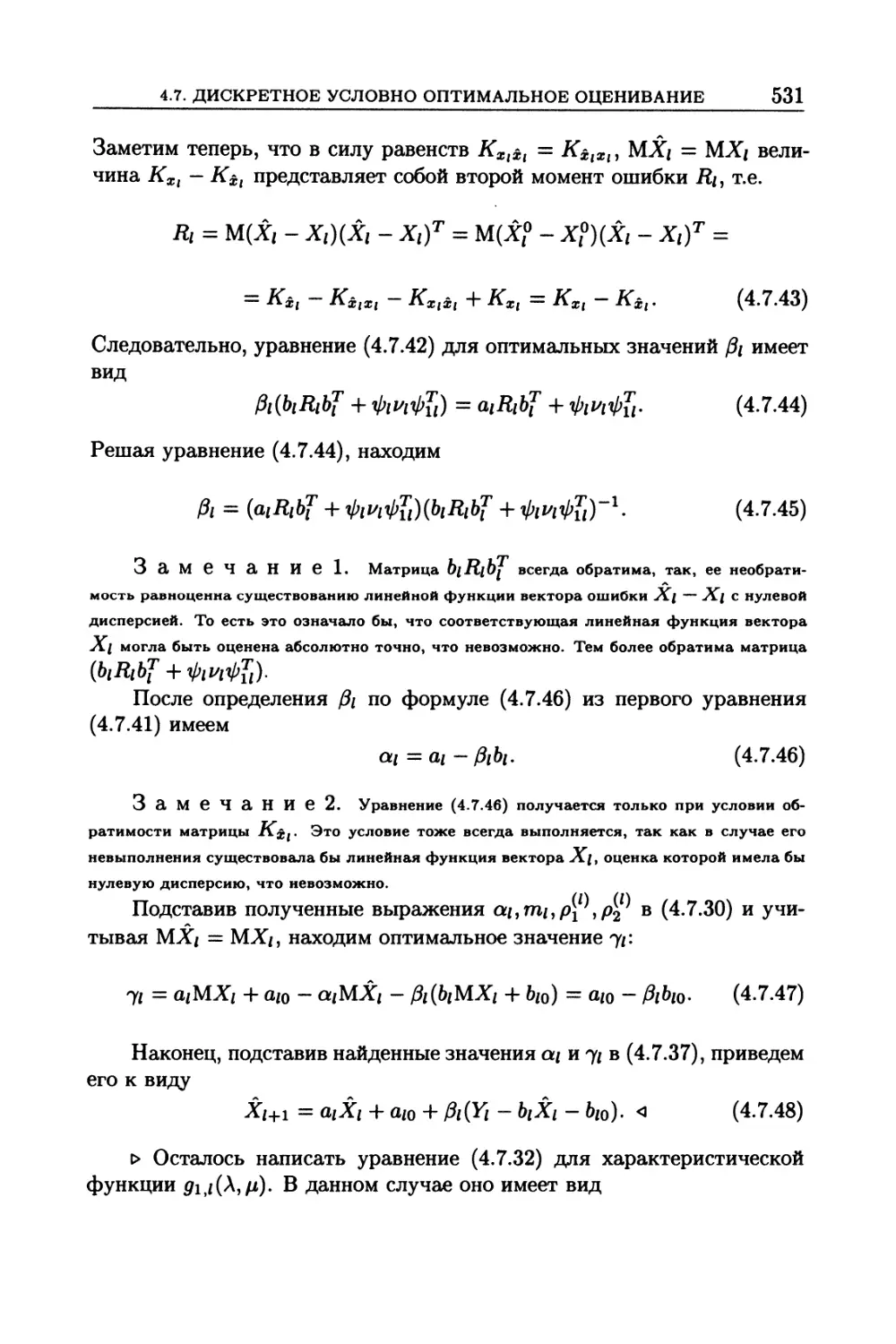

4.7. Дискретное условно оптимальное оценивание,

распознавание и адаптация ........................................... 518

4.7.1. Постановка задач дискретного условно оптимального оценивания (518).

4.7.2. Классы допустимых фильтров (519). 4.7.3. Дискретный фильтр Пугачева

для нелинейных регрессионных уравнений (520). 4.7.4. Фильтры Пугачева для не-

линейных авторегрессионных уравнений (526). 4.7.5. О двух трактовках дискрет-

ных фильтров Калмана и Пугачева (528). 4.7.6. Применение дискретной условно

8

Оглавление

оптимальной фильтрации к задачам распознавания, идентификации и адаптации

(529). 4.7.7. Дискретный линейный фильтр Пугачева для дискретных линейных

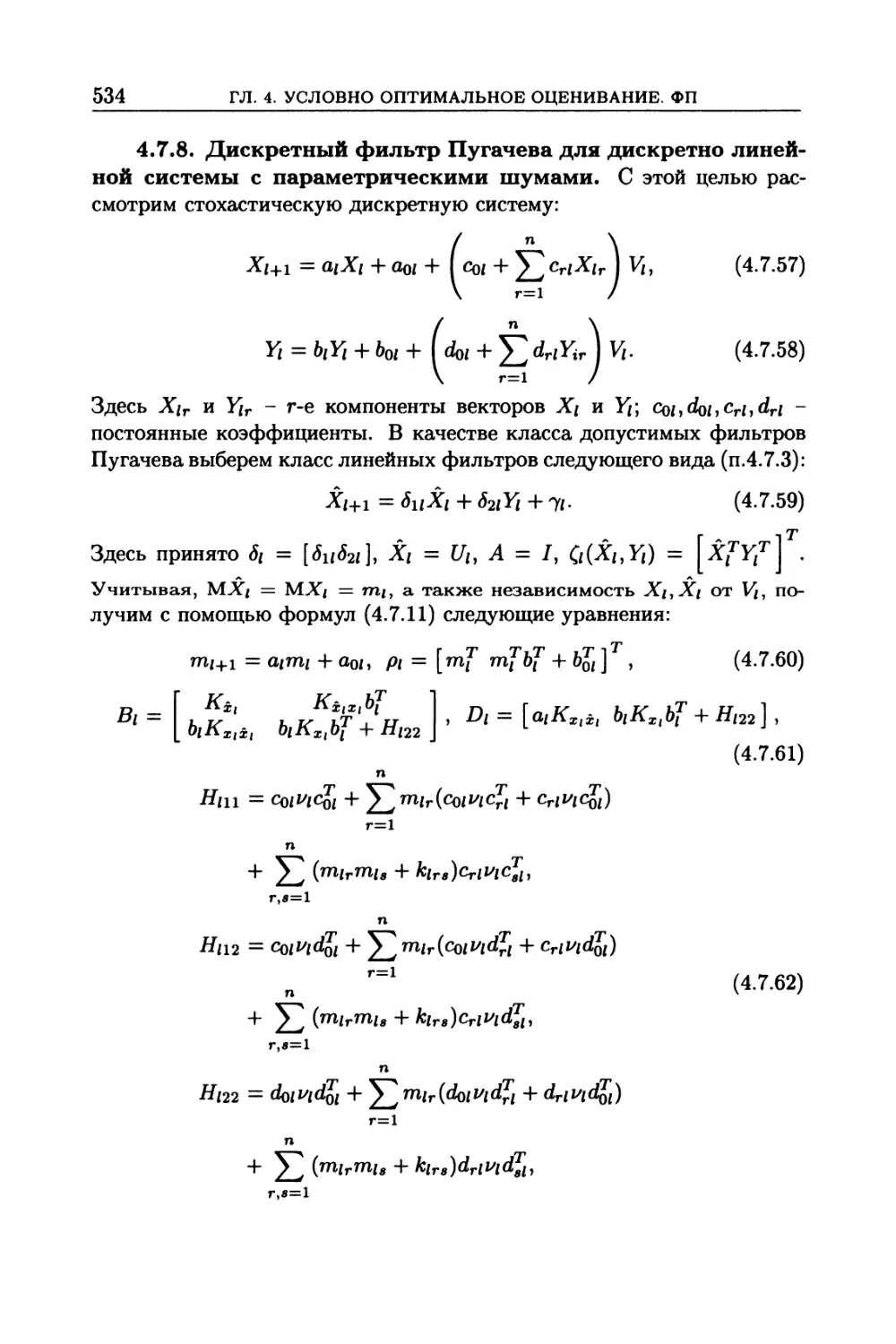

стохастических систем (529). 4.7.8. Дискретный фильтр Пугачева для дискретно

линейной системы с параметрическими шумами (534).

4.8. Дискретная условно оптимальная экстраполяция

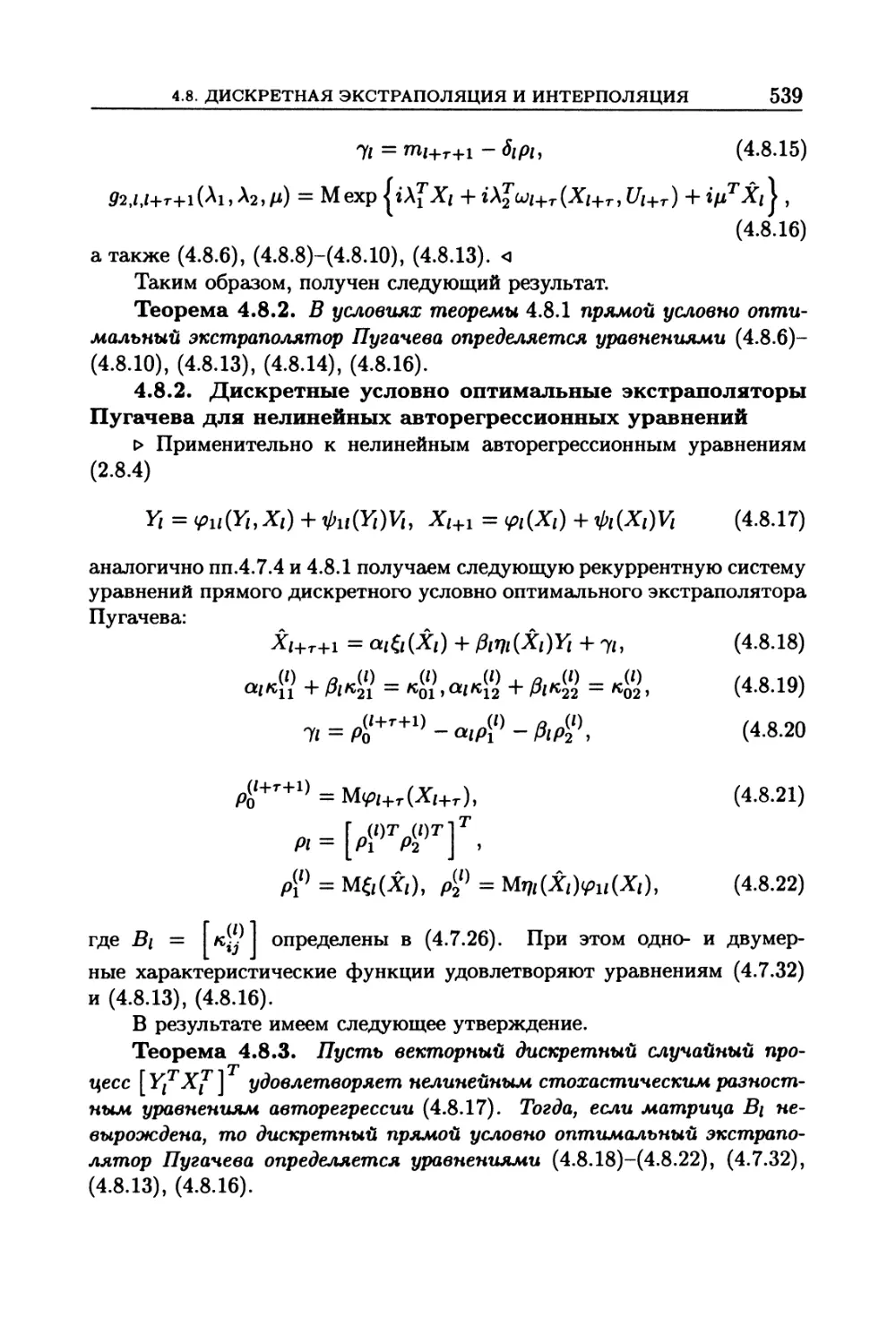

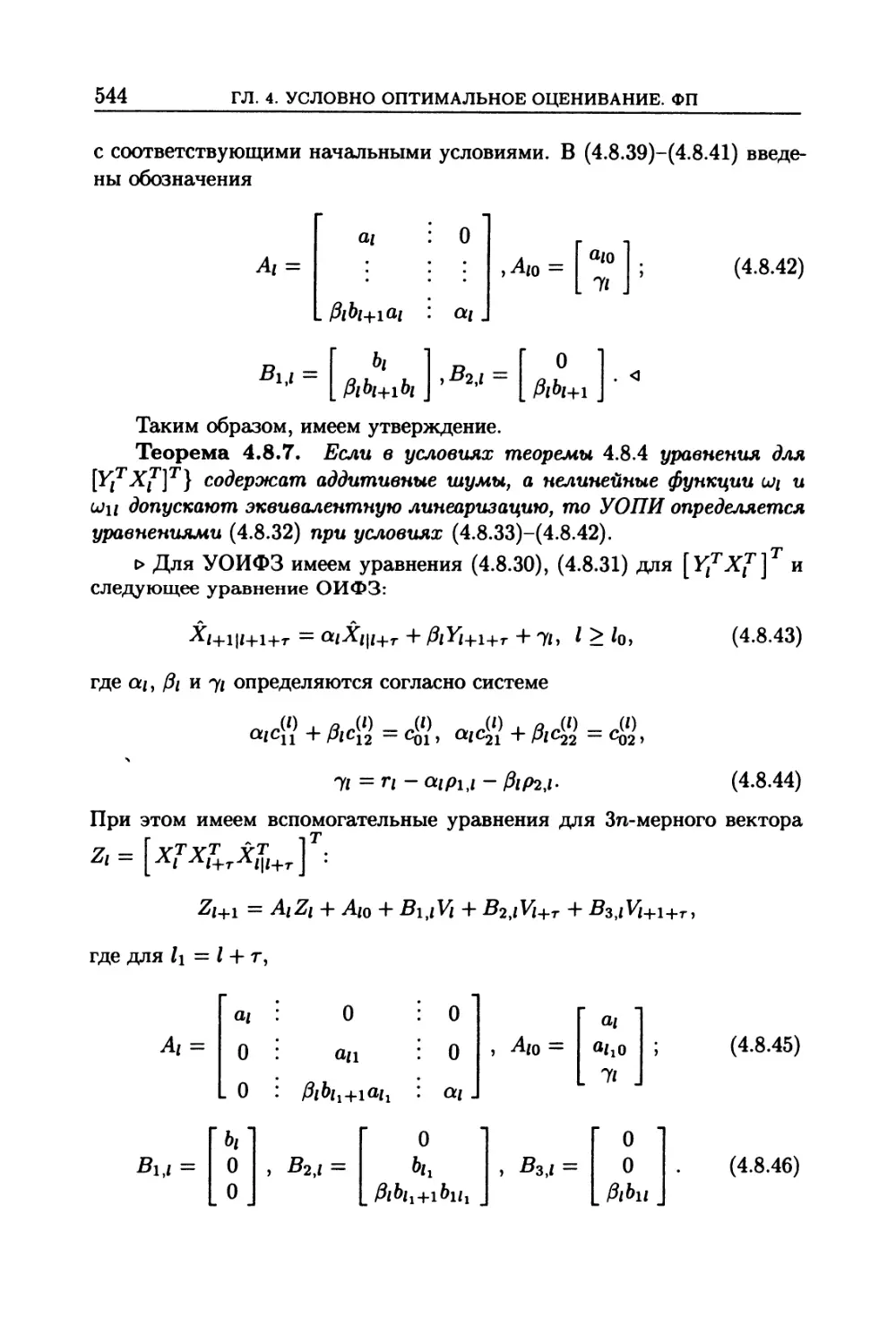

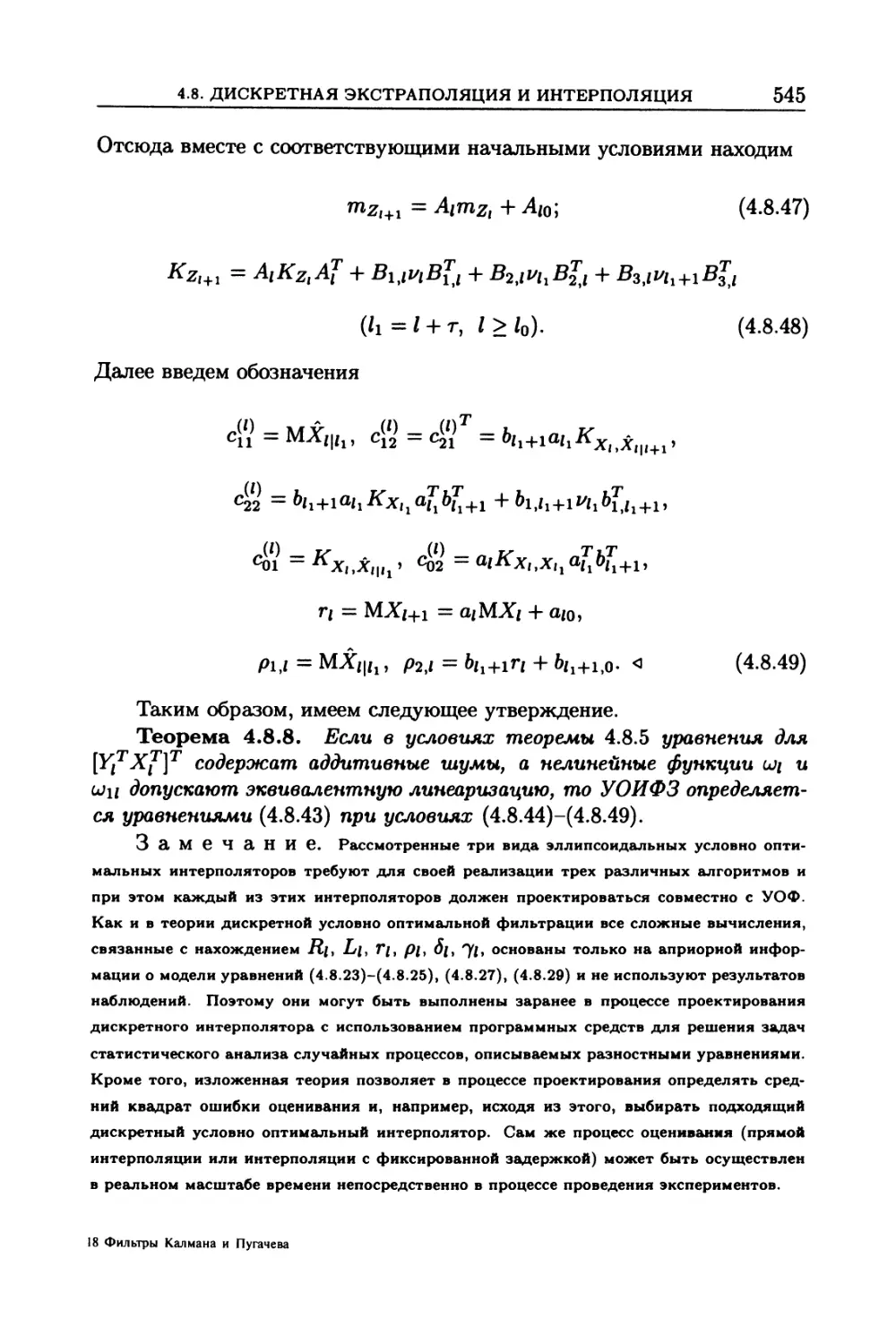

и интерполяция .................................................... 537

4.8.1. Дискретная условно оптимальная экстраполяция для нелинейных регресси-

онных уравнений (537). 4.8.2. Дискретные условно оптимальные экстраполяторы

Пугачева для нелинейных авторегрессионных уравнений (539). 4.8.3. Постановка

задачи дискретной условно оптимальной интерполяции (540). 4.8.4. Условно оп-

тимальная интерполяция (540). 4.8.5. Условно оптимальная интерполяция с фик-

сированной задержкой (541). 4.8.6. Условно оптимальная обратная интерполяция

(542). 4.8.7. Линеаризованные дискретные условно оптимальные интерполяторы

(543).

4.9. Эллипсоидальные субоптимальные и условно

оптимальные фильтры ............................................... 546

4.9.1. Эллипсоидальные субоптимальные фильтры, основанные на приближен-

ном решении фильтрационных уравнений (546). 4.9.2. Модифицированные эл-

липсоидальные субоптимальные фильтры, основанные на прибилженном решении

фильтрационных уравнений для ненормированных апостериорных распределений

(552). 4.9.3. Эллипсоидальные субоптимальные фильтры, основанные на МЭЛ

(563). 4.9.4. Эллипсоидальные условно оптимальные фильтры и экстраполято-

ры (565). 4.9.5. Дискретные эллипсоидальные условно оптимальные фильтры и

экстраполяторы (569).

4.10. Условно оптимальное оценивание по бейесовому критерию 571

4.10.1. Постановка задачи (571). 4.10.2. Уравнение для оптимальных коэффи-

циентов (572). 4.10.3. Уравнение для оптимального коэффициента OL при огра-

ничениях (575). 4.10.4. Определение моментов вектора (577).

4.10.5. Уравнения фильтра Калмана-Быоси по бейесовому критерию (577). 4.10.6.

Условно оптимальные фильтры по сложным статистическим критериям (579).

4.10.7. Фильтр Калмана-Быоси по сложному статистическому критерию (582).

4.10.8. Дискретные условно оптимальные фильтры по бейесовому и сложному

статистическому критериям (583).

4.11. Дополнения и задачи .......................... 587

5. Рудольф Эмиль Калман ............................ 608

6. Пугачев Владимир Семенович ...................... 611

7. Библиографические замечания ..................... 616

Список литературы................................... 620

Предметный указатель................................ 632

Памяти академика

Владимира Семеновича Пугачева

посвящается

ПРЕДИСЛОВИЕ

В монографии дается систематическое изложение теории

фильтров Калмана и Пугачева для обработки информации в сложных

стохастических системах, а также приводятся новые результаты фун-

даментальных работ, выполненных в Институте проблем информатики

Российской академии наук в рамках научного направления “Стохасти-

ческие системы и стохастические информационные технологии”. В кни-

ге впервые в полном объеме описываются непрерывные и дискретные

фильтры Пугачёва.

Книга предназначена для научных работников и инженеров в об-

ласти прикладной математики, теории управления и информатики, а

также в других областях науки и техники, связанных с обработкой

информации в системах, поведение которых описывается стохастиче-

скими дифференциальными, интегральными, интегродифференциаль-

ными, разностными и другими уравнениями (стохастические системы).

Книга может представлять интерес для математиков, специализирую-

щихся в области стохастических уравнений и их приложений. Она мо-

жет быть полезна студентам высших учебных заведений, обучающихся

по специальности “Прикладная математика”. Единая методика, тща-

тельный. подбор примеров и задач (их свыше 300) позволяют использо-

вать книгу широкому кругу студентов, аспирантов и преподавателей.

Монография состоит из четырех глав. В конце каждой главы в виде

специального раздела даны дополнения и задачи для упражнений.

В главе 1 приводятся необходимые сведения из теории стохасти-

ческих систем. Рассматриваются математические модели динамиче-

ских систем в условиях случайных возмущений и их характеристики.

Излагаются основные понятия теории распределений случайных вели-

чин и случайных функций. Изучаются различные вероятностные меры

случайных функций и вероятности событий, связанные со случайны-

ми функциями. Обсуждаются вопросы устойчивости, управляемости и

наблюдаемости линейных систем. Излагаются основные понятия, свя-

занные с математическим ожиданием случайных величин в линейных

10

Предисловие

пространствах, рассматриваются свойства операторов моментов второ-

го и высших порядков, устанавливаются свойства характеристических

функционалов, а также соответствие между вероятностными мерами

и характеристическими функционалами. Особое внимание уделяется

теории ортогональных разложений одно- и многомерных плотностей.

Изучаются условные операторы моментов и их свойства. Приводят-

ся элементы теории регрессии. Рассматриваются вопросы сходимости,

непрерывности и дифференцируемости случайных функций. Обсуж-

даются вопросы интегрируемости случайных функций как по неслу-

чайной, так и по случайной мере, излагаются элементы теории стоха-

стических интегралов Ито, симметризованного интеграла Стратонови-

ча и 0-интеграла. Рассматриваются стохастические интегралы по ме-

рам Винера и Пуассона. Устанавливается связь между общей формой

процесса с независимыми приращениями и интегралом Ито. Приво-

дятся формулы Ито для дифференцирования нелинейных функций в

случаях винеровского, пуассоновского и общего случайного процесса с

независимыми приращениями. Описываются методы приведения урав-

нений непрерывной стохастической системы к стохастическим диффе-

ренциальным уравнениям и их численного интегрирования. Даются

сведения по теории одно- и многомерных распределений в непрерыв-

ных, дискретных и непрерывно-дискретных системах в конечномерных

пространствах. Приведены известные уравнения (Фоккера-Планка-

Колмогорова, Феллера-Колмогорова, Пугачева и др.), описывающие

одно- и многомерные распределения. Рассмотрены основные методы

теории линейных стохастических систем применительно к непрерыв-

ным, дискретным и непрерывно-дискретным системам. Последние два

раздела главы 1 посвящены приближенным методам теории нелиней-

ных стохастических систем, основанным на параметризации распреде-

лений. Рассматриваются методы нормализации, нормальной аппрокси-

мации и статистической линеаризации, методы начальных и централь-

ных моментов, ортогональных разложений и квазимоментов, эллипсо-

идальной аппроксимации и линеаризации, а также их модификации.

Глава 2 посвящена теории оптимального (в смысле минимума сред-

ней квадратической) оценивания состояния и параметров стохастиче-

ских систем по результатам наблюдения (теория оптимальной филь-

трации) и фильтрам Калмана для стохастических дифференциальных

и дискретных систем. После постановки задач оценивания (фильтра-

ции, экстраполяции и интерполяции) выведены общая формула для оп-

тимальной оценки вектора состояния, уравнения, определяющие одно-

мерно апостериорное распределение вектора состояния системы, и фор-

Предисловие

11

мулы для стохастических дифференциалов апостериорных средних и

моментов второго порядка, а также формулы для стохастических диф-

ференциалов апостериорных вероятностей в задаче распознавания. За-

тем излагается точная общая теория оптимальной линейной фильтра-

ции. В этом случае уравнения оптимальной фильтрации допускают

точное решение. Излагаются свойства уравнений Риккати. После по-

дробного изложения теории стационарных и нестационарных фильтров

Калмана-Быоси подробно изучается случай автокоррелированной по-

мехи в наблюдениях, которая может быть представлена как результат

преобразования белого шума линейным формирующим фильтром. Изу-

чаются дифференцирующие свойства оптимальных фильтров. Дает-

ся точное решение задачи оптимальной экстраполяции и интерполяции

вектора состояния линейной системы. Затем рассматривается случай,

когда уравнения системы и наблюдения линейны только относительно

вектора состояния и нелинейны относительно наблюдаемого процесса.

Особое внимание уделено уравнениям оптимальной фильтрации для не-

нормированных распределений. Далее излагается теория оптимального

оценивания и дискретных фильтров (экстраполяторов и интерполято-

ров) Калмана. Рассматриваются вопросы устойчивости, наблюдаемо-

сти и управляемости непрерывных и дискретных стохастических си-

стем и фильтров Калмана. В последнем разделе изучаются вопросы

оптимального оценивания, распознавания и адаптации.

Глава 3 содержит изложение теории нелинейного субоптимального

(приближенного) оценивания с помощью обобщенных фильтров Кал-

мана для нелинейных непрерывных и дискретных стохастических си-

стем. Рассмотрены две группы методов субоптимальной нелинейной

фильтрации. К первой группе относятся методы, основанные на при-

ближенном решении уравнений оптимальной нелинейной фильтрации:

метод нормальной аппроксимации апостериорного распределения, ме-

тод моментов, метод семиинвариантов и методы, основанные на ор-

тогональных разложениях апостериорных распределений, в частности

метод квазимоментов. Все эти методы, кроме метода нормальной ап-

проксимации, принципиально позволяют получить решение задачи оп-

тимальной фильтрации с любой степенью точности. Однако возможно-

сти практической реализации соответствующих фильтров сильно огра-

ничены из-за сложности получающихся алгоритмов. Ко второй группе

относятся методы, основанные на упрощении уравнений оптимальной

нелинейной фильтрации. Фильтры, даваемые этими методами: обоб-

щенный фильтр Калмана-Бьюси, фильтры второго порядка и гауссов

фильтр, по сложности реализации равноценны фильтру метода нор-

12

Предисловие

мальной аппроксимации. Однако ввиду произвольности допущений,

лежащих в основе этих фильтров, вопрос о точности их приближения к

оптимальному фильтру остается неясным. Изложен метод априорного

исследования точности субоптимальных фильтров. Особое внимание

уделено уравнениям нелинейной субоптимальной фильтрации для не-

нормированных распределений. Рассмотрены модифицированные ме-

тоды нормальной аппроксимации, моментов и ортогональных разло-

жений. Заключительный раздел главы 3 содержит изложение методов

дискретного субоптимального оценивания и распознавания. Рассматри-

ваются неадаптивные и адаптивные обобщенные дискретные фильтры

Калмана.

Глава 4 посвящена теории нелинейного условно оптимального оце-

нивания (фильтрации, экстраполяции и интерполяции) вектора состоя-

ния системы и условно оптимального оценивания параметров системы

(теория условно оптимальной фильтрации Пугачева). Теория Пугаче-

ва позволяет строить фильтры минимальной сложности, сравнительно

легко реализуемые в задачах практики. Кроме того, она дает возмож-

ность получать фильтры, равноценные по сложности любому данному

субоптимальному фильтру, но обладающие более высокой точностью.

В этом состоит существенное преимущество методов условно оптималь-

ной фильтрации Пугачева по сравнению с методами субоптимальной

фильтрации главы 3. После изложения основной идеи условно опти-

мального оценивания, постановки соответствующих задач даются об-

щие методы построения фильтров и экстраполяторов. Рассматривается

применение теории условно оптимальной фильтрации для решения за-

дачи распознавания в случае линейного уравнения наблюдения. Затем

эти методы распространяются на случай автокоррелированной помехи

в наблюдениях, представимой в виде выходного сигнала формирующе-

го фильтра, описываемого стохастическим дифференциальным уравне-

нием (не обязательно линейным). Дается применение теории условно

оптимальной фильтрации и экстраполяции к линейным системам с па-

раметрическими шумами. Подробно рассматривается теория дискрет-

ного условно оптимального оценивания, распознавания и адаптации.

Излагается теория эллипсоидальных субоптимальных и условно опти-

мальных фильтров и экстраполяторов Пугачева.

В заключительном разделе получены основные уравнения услов-

но оптимальной фильтрации по бейесовым и сложным статистическим

критериям. Рассмотрены фильтры Калмана-Бьюси и Пугачева по та-

ким же критериям. Приведены уравнения фильтров Калмана и Пуга-

Предисловие

13

чева для трех задач интерполяции процессов в дискретных стохастиче-

ских системах.

Современное алгоритмическое и программное обеспечение филь-

тров Калмана реализовано в виде универсального программного обеспе-

чения в большинстве стандартных научных и научно-технических биб-

лиотек, пакетов прикладных программ, специлизованного программно-

го обеспечения для различных средств вычислительной техники (см.

библиографию).

В разделах 5 и 6 автор счел необходимым привести портреты и

краткие биографические сведения о Р.Э. Калмане (р.1930) и В.С. Пуга-

чеве (1911-1998).

Биографические замечания и список литературных источников

приведены в конце книги. Автор ни в коей мере не претендует на пол-

ноту списка. В нем указаны только те источники, на которые даются

ссылки в тексте.

Книга разбита на главы, разделы и пункты. Формулы (примеры)

нумеруются с указанием номеров главы и раздела, например, (1.2.3)

означает, что формула (3) принадлежит разделу 2 главы 1.

Для удобства читателей формулировки основных результатов и вы-

делены в виде предложений. Начало и конец выводов, доказательств

и рассуждений, приводящих к определенным результатам, отмечены

треугольными указателями о и <1.

Книга может использоваться разными категориями читателей.

Для усвоения изложенного в ней материала в полном объеме необхо-

димо знание основ теории вероятностей, например книги В.С. Пугаче-

ва “Теория вероятностей и математическая статистика” (Наука, 1979,

2002), В.С. Пугачев и И.Н. Синицын “Теория стохастических систем”

(Логос, 2000, 2004), а также основ функционального анализа в объе-

ме книги В.С. Пугачева “Лекции по функциональному анализу” (Изд.

МАИ, 1996).

Как показывает многолетний педагогический опыт автора, книга

может быть использована для чтения стандартных и специализирован-

ных курсов по теории вероятностей и стохастическому анализу, стати-

стическим основам системного анализа, информатики, радиотехники,

теории управления и связи, теории надежности конструкций, динамике

машин и механизмов, а также фрагментов в специализированных кур-

сах, например, аналитической механики стохастических систем, стати-

стической теории колебаний и устойчивости и др. (Синицын 1996).

14

Предисловие

Многие дополнения и задачи, приведенные в конце каждой из глав,

имеют самостоятельный интерес, носят комплексный характер, а пото-

му и могут быть использованы для курсовых и дипломных работ.

Раздел 4.10 и пп.2.12.5, 3.6.1-3.6.6, 4.8.3-4.8.7 написаны на базе сов-

местных работ с В.И. Шином (Gwangju Institute of Science and Tech-

nology, South Korea), а также разработанных им специально для на-

стоящей книги дополнений и комментариев. Раздел 4.9 и п. 1.8.4 под-

готовлены совместно с В.И. Синицыным. Дополнения 4.11.20-4.11.22

разработаны совместно с Э.Р. Корепановым. Б.Г. Доступов, И.Е. Каза-

ков, А.В. Добровидов, Р.А. Ивановский, А.В. Борисов, В.В. Белоусов,

Э.Р. Корепанов, В.И. Синицын, А.В. Босов, М.Е. Шайкин, О.С. Ушмаев

предоставили автору материалы для задач и дополнений.

Список литературы и предметный указатель составлен совместно

с И.В. Синицыной и Хоанг Тхо Ши. Считаю своим приятным долгом

выразить им благодарность за неоценимую помощь.

Автор благодарен В.В. Белоусову за помощь в подготовке рисун-

ков, Е.Н. Федотовой - за подготовку нескольких вариантов оригинал-

макета, а редакторам Е.В. Комаровой и Н.А. Власовой за большой труд

по подготовке рукописи к печати.

Без помощи Российского фонда фундаментальных исследований

и издательства “Логос” этот многолетний труд, посвященный памяти

академика В.С. Пугачева, не был бы издан.

Москва 1998 — 2005 гг.

ГЛАВА 1

СВЕДЕНИЯ ИЗ ТЕОРИИ

СТОХАСТИЧЕСКИХ СИСТЕМ

Глава 1 содержит необходимые сведения по моделям непрерывных

и дискретных систем (раздел 1.1) и по теории случайных функций (раз-

делы 1.2 и 1.3). Основы стохастического анализа изложены в разде-

ле 1.4. Элементы общей теории стохастических систем рассматривают-

ся в разделе 1.5. Методы теории линейных и нелинейных стохастиче-

ских систем кратко описаны в разделах 1.6-1.8. В конце главы даны

дополнения и задачи для упражнений.

1.1. Математические модели систем и их характеристики

1.1.1. Математические модели непрерывных систем. Как

известно (ТСтС, раздел 1.1), в практических задачах системой обыч-

но называют любую совокупность взаимодействующих предметов лю-

бой природы. Первым шагом к построению математической модели

системы является математическое описание того, что система получа-

ет на входе и выдает на выходе. Это описание состоит в определе-

нии двух множеств величин, связанных однонаправленной причинно-

следственной зависимостью, с помощью которых можно определить

внешние воздействия на систему и то, что она дает на выходе в каждый

данный момент времени. Величины, определяющие внешние воздей-

ствия на систему, называются входными сигналами. Величины, опре-

деляющие действие системы на окружающую среду и, в частности, на

другие системы, называются выходными сигналами системы. Обычно

входные сигналы (причины) не зависят от выходных сигналов, в то вре-

мя как выходные сигналы (следствия) принципиально зависят от своих

причин, т. е. от входных сигналов.

Кроме входных и выходных сигналов, для построения математи-

ческой модели системы часто приходится вводить еще некоторые вспо-

могательные величины, в число которых могут включаться величины,

характеризующие действия различных частей системы друг на друга

(внутренние взаимодействия частей системы). Все эти величины, ха-

рактеризующие положение (состояние) системы в каждый данный мо-

мент времени, обычно называются переменными состояниями систе-

мы.

16

ГЛ. 1. СВЕДЕНИЯ ИЗ ТЕОРИИ СТОХАСТИЧЕСКИХ СИСТЕМ

В дальнейшем мы будем называть входным сигналом системы всю

совокупность ее входных сигналов, выходным сигналом - всю совокуп-

ность ее выходных сигналов и вектором состояния - всю совокупность

переменных состояний системы.

Множество всех возможных входных сигналов системы будем на-

зывать ее пространствам входных сигналов, множество всех возмож-

ных выходных сигналов системы - ее пространством выходных сиг-

налов, а множество всех возможных векторов состояния системы - ее

пространством состояний. Входной и выходной сигналы системы как

определенные функции времени, а также изменение вектора состояния

со временем характеризуют функционирование или, как часто говорят,

состояние системы.

После определения входного и выходного сигналов и вектора состо-

яния системы для получения ее математической модели остается уста-

новить соотношения между этими величинами. Эти соотношения могут

быть детерминированными или содержать некоторые элементы неопре-

деленности. В последнем случае обычно пользуются вероятностным

подходом, приписывая случайный (стохастический) характер и соот-

ветствующие распределения всем неопределенным величинам. Таким

образом, мы приходим к следующему определению математической мо-

дели системы.

Математической моделью системы называется совокупность

четырех элементов: 1) пространства состояний, 2) пространства вход-

ных сигналов, 3) пространства выходных сигналов и 4) соотношений,

связывающих входной и выходной сигналы и вектор состояния системы.

Понятия входного и выходного сигналов и вектора состоя-

ния относятся не к самой системе, а к ее математической модели.

В действительности состояние любой системы, все внешние воздействия

на нее и все ее действия на окружающую среду и, в частности, на дру-

гие системы невозможно охарактеризовать никаким обозримым и тем

более конечным множеством величин. Поэтому, говоря о входном и вы-

ходном сигналах и о состоянии системы, мы всегда имеем в виду вход-

ной и выходной сигналы и состояние принятой математической модели

системы.

Модель системы называется детерминированной, если каждой ре-

ализации ее входного сигнала соответствует одна определенная реали-

зация выходного сигнала. Модель системы называется стохастиче-

ской, если каждой реализации ее входного сигнала соответствует вполне

определенное вероятностное распределение ее выходного сигнала. Для

одной и той же системы можно построить много различных моделей.

1.1. МАТЕМАТИЧЕСКИЕ МОДЕЛИ СИСТЕМ И ИХ ХАРАКТЕРИСТИКИ 17

В зависимости от степени детальности характеристики поведения си-

стемы и количества учитываемых факторов одни модели будут проще,

другие - сложнее. Чем больше факторов учитывает модель, тем она

сложнее, тем полнее и в принципе точнее она описывает поведение си-

стемы. Однако точность сложной модели может оказаться иллюзорной.

Из-за ограниченности и неточности исходных данных, используемых

при ее построении, чрезмерно сложная модель может оказаться менее

точной, чем более простая. Поэтому степень сложности модели долж-

на быть согласована с доступной информацией, используемой для ее

построения.

Что касается сложных систем, то, как правило, никакая модель не

может с достаточной точностью воспроизвести все функции. Одни мо-

дели будут лучше по одним показателям, другие - по другим. Поэтому

для сложных систем строят не одну, а несколько моделей и в зависи-

мости от цели применяют ту или иную. При этом одни модели могут

быть детерминированными, а другие - стохастическими.

Входной и выходной сигналы любой системы представляют собой

функции времени. Если они определены для всех моментов времени,

начиная с некоторого начального момента, то модель системы назы-

вается непрерывной. Соответственно и саму систему называют в этом

случае непрерывной. Если реализации входного и выходного сигналов

определены только на дискретных множествах моментов времени, то

модель системы называется дискретной. В этом случае и саму систе-

му обычно называют дискретной (импульсной). Впрочем, дискретные

модели часто применяются и для описания поведения непрерывных си-

стем. Для расчетов на цифровых ЭВМ всегда применяются дискретные

модели, независимо от того, являются ли соответствующие системы не-

прерывными или дискретными.

Общие характеристики непрерывных систем. Будем счи-

тать, что математическая модель изучаемой системы построена. По-

этому, говоря о характеристиках системы, будем иметь в виду харак-

теристики ее математической модели. Основной характеристикой си-

стемы является ее оператор, определяющий механизм формирования

выходного сигнала по данному входному сигналу. Оператор детерми-

нированной системы отображает пространство входных сигналов в

пространство выходных сигналов. Оператор стохастической системы

ставит в соответствие каждому входному сигналу определенное рас-

пределение выходного сигнала (конечно, зависящее от входного сигна-

ла). Другими словами, оператор стохастической системы отобража-

ет пространство входных сигналов в пространство всех возможных

18

ГЛ. 1. СВЕДЕНИЯ ИЗ ТЕОРИИ СТОХАСТИЧЕСКИХ СИСТЕМ

распределений на пространстве выходных сигналов.

Рассмотрим непрерывную систему с конечномерными входными и

выходными сигналами, представляющими собой, как правило, непре-

рывные ограниченные функции времени. Оператор детерминирован-

ной системы отображает пространство непрерывных функций в такое

же пространство. Пусть x(t) - входной сигнал детерминированной си-

стемы, представляющий собой непрерывную скалярную или п-мерную

векторную функцию времени y(t) - выходной сигнал, представляю-

щий собой непрерывную скалярную или m-мерную векторную функ-

цию t. Обозначим буквой А оператор системы. Соотношение между

входным и выходным сигналами детерминированной системы можно

записать в виде операторного уравнения

y(t) = Ax(t). (1-1.1)

Эта краткая запись включает всю совокупность математических one-

раций, которые надо выполнить над функцией ar(t), чтобы определить

функцию y(t).

Детерминированная система называется физически возможной,

если значение ее выходного сигнала y(t) в каждый момент t не зависит

от значений входного сигнала х(т) при т > t. Таким образом, значе-

ние выходного сигнала физически возможной системы y(t) в каждый

момент t является функционалом от входного сигнала х(т}, заданно-

го в интервале to < т < t. Строго говоря, y(t) представляет собой

m-мерный вектор, компоненты которого являются функционалами от

х(т), т G Для краткости мы называем векторную величину y(t)

функционалом, имея в виду m-мерный векторный функционал.

Стохастическая система называется физически возможной, ес-

ли распределение значения ее выходного сигнала Y(t) в любой мо-

мент t не зависит от значений входного сигнала х(т) при т > t.

Пусть задан некоторый невозмущенный входной сигнал x(t)

системы и пусть y(t) - соответствующий ему выходной сигнал, кото-

рый также назовем невозмущенным. Всякий другой входной сигнал

x'(t) будем называть возмущенным входным сигналом, а соответству-

ющий ему выходной сигнал y'(t) - возмущенным выходным сигналом.

Отклонения входного и выходного сигналов от невозмущенных опреде-

лим как Дя(£) = x'(t) — x(t) и Д?/(^) = y'it) — y(t). Детерминированная

система (1.1.1) называется устойчивой относительно заданного невоз-

мущенного сигнала, если отклонение Д?/(^) остается сколь угодно ма-

лым при любом достаточно малом отклонении Дзг(^) входного сигнала,

1.1. МАТЕМАТИЧЕСКИЕ МОДЕЛИ СИСТЕМ И ИХ ХАРАКТЕРИСТИКИ 19

т. е. для любого е > 0 существует такое 6 = 6(e) > 0, что | Ay(t) | < е

при t > to, когда | Ax(t) | < 6 при всех t > to.

Стохастическая система называется устойчивой относительно за-

данного невозмущенного сигнала почти наверное (с вероятностью 1),

если отклонение ее выходного сигнала ДУ (t) сколь угодно мало с веро-

ятностью 1 при любом достаточно малом отклонении входного сиг-

нала Дя(£). Стохастическая система называется устойчивой отно-

сительно заданного невозмущенного сигнала по вероятности, если при

любом е > 0 существует такое 6 = 6(e) > 0, что lim Р\ sup |ДУ (t)| >

t-*00 \t>t0

> е I = 0 при всех Ax(t), удовлетворяющих условию sup | Ax(t) | < 6.

/ t>t0

Стохастическая система называется устойчивой относительно за-

данного невозмущенного сигнала в р-среднем, р > О, если математи-

ческое ожидание М| ДУ (t) |р остается сколь угодно малым при всех

достаточно малых отклонениях входного сигнала Дя(£).

Стохастическая система устойчива по вероятности, если она

устойчива в р-среднем. Точно так же из устойчивости почти на-

верное вытекает устойчивость по вероятности. Из р-устойчивости

при данном р следует р\ -устойчивость при всех р\ < р. Обратное в

общем случае неверно.

Говоря об устойчивости системы, в прикладных задачах всегда име-

ют в виду устойчивость всех реализаций происходящих в ней процессов.

С этой точки зрения наибольшее значение для приложений имеет по-

нятие устойчивости почти наверное. Однако в практических задачах

часто приходится ограничиваться устойчивостью в среднем (р = 1) или

в среднем квадратическом (р = 2). Класс систем, устойчивых в сред-

нем квадратическом (с.к. устойчивых), и класс систем, устойчивых

почти наверное (п.н. устойчивых), являются подклассами класса си-

стем устойчивых по вероятности, причем пересечение этих подклассов

непусто.

Система называется линейной, если при любых числах N,

Ci , ... , с/у и при любых функциях Xi(t) , ... , Xl\f(t)

N

' N

Л< ^2cuxu(t) ► = y^ cuAxu(t).

(1-1.2)

Это определяющее свойство линейных систем обычно называется прин-

ципом суперпозиции. Поэтому линейные системы можно определить

как такие системы, для которых справедлив принцип суперпозиции

(1.1.2).

20

ГЛ. 1. СВЕДЕНИЯ ИЗ ТЕОРИИ СТОХАСТИЧЕСКИХ СИСТЕМ

Система называется нелинейной, если принцип суперпозиции

(1.1.2) для нее не выполняется или выполняется только при некоторых

вполне определенных N, xi(t), ... , x^(t), ci, ... , с^.

В прикладных задачах обычно удается представить модель любой

системы с конечномерными векторами входного и выходного сигналов,

а также вектора состояния в виде соединения конечного числа типовых

линейных систем и безынерционных нелинейных звеньев. О послед-

них говорим, имея в виду, что практически любая нелинейность дает

на выходе определенную функцию текущего значения ее входного сиг-

нала. А именно значение выходного сигнала нелинейного звена в лю-

бой момент t представляет собой определенную функцию значения его

входного сигнала в тот же момент t и не зависит от значений входного

сигнала до момента t:

y(i) (1.1.3)

где через x(t) и y(t) обозначены входной и выходной сигналы нели-

нейного звена. Функция р полностью характеризует безынерционное

нелинейное звено и поэтому принимается за его характеристику. Вход-

ной сигнал нелинейного звена в общем случае представляет собой век-

тор, компонентами которого служат некоторые переменные состояния

системы и, может быть, некоторые ее входные сигналы.

Большую часть непрерывных линейных систем, встречающихся на

практике, составляют системы, поведение которых описывается обык-

новенными дифференциальными уравнениями. При этом обычно все-

гда эти уравнения можно представить в стандартной форме Коши,

т. е. в виде системы уравнений первого порядка, решенных отно-

сительно производных. Добавив к уравнениям всех линейных частей

системы зависимости между входными и выходными сигналами всех

нелинейных звеньев, получим систему нелинейных дифференциальных

уравнений в форме Коши, описывающую нелинейную систему. Обо-

значим через z{f) = [zi(£).. .zp(£)]T вектор состояния системы, через

x(t) = [яДг)... xn(t)]T - векторный входной сигнал, а через y(t) =

= [з/i (£) • • • Ут(1)]Т ~ векторный выходной сигнал (здесь и в дальнейшем

Т - оператор транспонирования). Тогда дифференциальные уравнения,

описывающие поведение системы, в общем случае запишутся в виде

z = f{z, x,t), у = g(z, t), (1-1-4)

где f - р-мерная векторная функция векторов z, х и времени t, а

д - m-мерная векторная функция вектора z и времени t. Систему с ко-

нечномерными вектором состояния и значениями входного и выходного

1.1. МАТЕМАТИЧЕСКИЕ МОДЕЛИ СИСТЕМ И ИХ ХАРАКТЕРИСТИКИ 21

сигналов, описываемую обыкновенным дифференциальным уравнени-

ем и формулой для выходного сигнала вида (1.1.4), будем для краткости

называть дифференциальной системой.

При данном начальном состоянии системы zq = z(£o) уравнения

(1.1.4) полностью и однозначно определяют оператор системы. Заме-

тим, что от начальных условий всегда можно избавиться, включив их в

вектор входного сигнала. В самом деле, уравнения (1.1.4) с начальным

условием z(fo) = zq можно написать в виде

z = /(г, х, t) + z06(t - tQ), у = g(z, t) (1.1.5)

и интегрировать их при нулевых начальных условиях z = 0 при t = to+e

и при сколь угодно малом е > 0. Приняв zq за дополнительную компо-

ненту вектора входных сигналов, т.е. за входной сигнал (п +р)-мерный

вектор x(f) = [^o"rEi(f)... xn(f)]T, можем утверждать, что уравнения

(1.1.5) с нулевыми начальными условиями полностью определяют опе-

ратор системы.

Рассмотрим линейную многомерную систему с п входами и т вы-

ходами. На основании принципа суперпозиции действие каждого вход-

ного сигнала на многомерную линейную систему можно рассматривать

отдельно, а затем результаты действия отдельных входных сигналов на

каждом выходе просуммировать.

Для нахождения реакции на А;-м выходе линейной системы на сиг-

нал, действующий на одном только Л-м входе, можно рассматривать

эту систему как систему с одним входом и одним выходом. Тогда для

вычисления реакции на А;-м выходе системы на любой сигнал, действу-

ющий на Л-м входе, при отсутствии сигналов на остальных входах, до-

статочно будет знать соответствующую весовую функцию gkh(t> т)- Эта

весовая функция представляет собой реакцию на к-м выходе системы на

единичный импульс, действующий на h-м входе в момент т, при отсут-

ствии сигналов на остальных входах. Совокупность весовых функций

9kh(t, г) (к = 1, ... , m; h = 1, ... , п), соответствующих всем входам и

выходам, является исчерпывающей характеристикой многомерной ли-

нейной системы.

Зная весовые функции многомерной линейной системы, соот-

ветствующие всем входам и выходам, и суммируя полученные резуль-

таты для каждого отдельного выхода по всем входам, найдем все вы-

ходные сигналы рассматриваемой линейной системы, соответствующие

одновременному действию всех входных сигналов. Таким образом, вы-

ходные сигналы 2/i(t), ... , ym(t) линейной системы с п входами и т

22

ГЛ. 1. СВЕДЕНИЯ ИЗ ТЕОРИИ СТОХАСТИЧЕСКИХ СИСТЕМ

выходами выражаются через ее входные сигналы zi(£), ... , xn(t) фор-

мулой

УМ = f

Л=1

9kh(t,r)xh(r)dr (k = l, ... ,m).

(1.1.6)

-оо

Вводя матрицу

’ 9п (t,r) 9l2(t,T) 9in(t,r) '

9(1,т) = 92i(t,r) 922(t,T) . 92n(t,T) (1.1.7)

- 9ml (^, Т) 9т2^,т) . • • 9mn(t, t) -

можно записать формулу (1.1.6) в виде

оо

y(t) = Ax(t) = J g(t,T)x(r)dT, (1.1.8)

—ОО

где x(t) = [ rci (t)... xn(t) ]T, y(t) = [yi(t)... ym(t) ]T - векторные входной

и выходной сигналы, представленные в виде матриц-столбцов. Матрич-

ная функция <?(t, т), определяемая формулой (1.1.7), называется весовой

функцией линейной системы с п входами и т выходами.

Для физически возможной линейной системы согласно определе-

нию имеем <?(£,т) =0 при т > t и формула (1.1.8) принимает вид

у(0

(1.1.9)

где to _ момент начала работы системы.

Для асимптотической устойчивости конечномерной линейной си-

стемы в целом необходимо и достаточно, чтобы все элементы матрицы

g(t, т) удовлетворяли условию:

оо

/ \dkh(t) т)| dr < оо (к = 1, ... , тп] h = 1, ... , п). (1.1.10)

—оо

1.1. МАТЕМАТИЧЕСКИЕ МОДЕЛИ СИСТЕМ И ИХ ХАРАКТЕРИСТИКИ 23

Для случая N раз непрерывно дифференцируемого входного сиг-

нала, причем в этом случае g(t, т) может содержать и линейную ком-

бинацию производных J-функций до порядка N включительно, необхо-

димое и достаточное условие (1.1.10) устойчивости линейной системы

заменится условием

(т - a)N 1g(t,a)da

dr < оо.

(1.1.11)

Стационарные системы. Стационарной называется такая си-

стема, у которой при любом сдвиге входного сигнала во времени без

изменения его формы (т.е. при замене x(t) на x(t — А) при любом А)

выходной сигнал претерпевает тот же сдвиг во времени, также не изме-

няя своей формы (т.е. y(t) заменяется на y(t- А)). Система, описывае-

мая дифференциальными уравнениями (1.1.4) или (1.1.5), стационарна

тогда и только тогда, когда правые части этих уравнений, т.е. функ-

ции f(z,x,t) и g^Zjt), не зависят явно от времени: f(z,x,t) = f(z,x),

9(z,t) = g(z).

Из определения стационарной системы следует, что весовая функ-

ция стационарной системы зависит только от разности ее аргумен-

тов. Основной особенностью физически возможных стационарных ли-

нейных систем является то, что любая асимптотически устойчивая

стационарная линейная система усиливает неограниченно долго дей-

ствующий входной сигнал, представляющий собой показательную

функцию est, без изменения его формы. Обозначив коэффициент уси-

ления показательного входного сигнала через

оо

Ф(в) = у w(a)e~s<rdcr, (1.1.12)

О

получим y(t) = Ф($)ев*. Эта формула показывает, что коэффициент

усиления Ф($) показательной функции зависит от параметра s. Этот

коэффициент называется передаточной функцией Ф($) стационарной

линейной системы.

Передаточная функция многомерной системы определится как т х

xn-матрица, элементами которой служат передаточные функции от

всех входов ко всем выходам, рассматриваемым по отдельности.

Формула (1.1.12) показывает, что передаточная функция стацио-

нарной линейной системы Ф($) является преобразованием Лапласа ее

24

ГЛ. 1. СВЕДЕНИЯ ИЗ ТЕОРИИ СТОХАСТИЧЕСКИХ СИСТЕМ

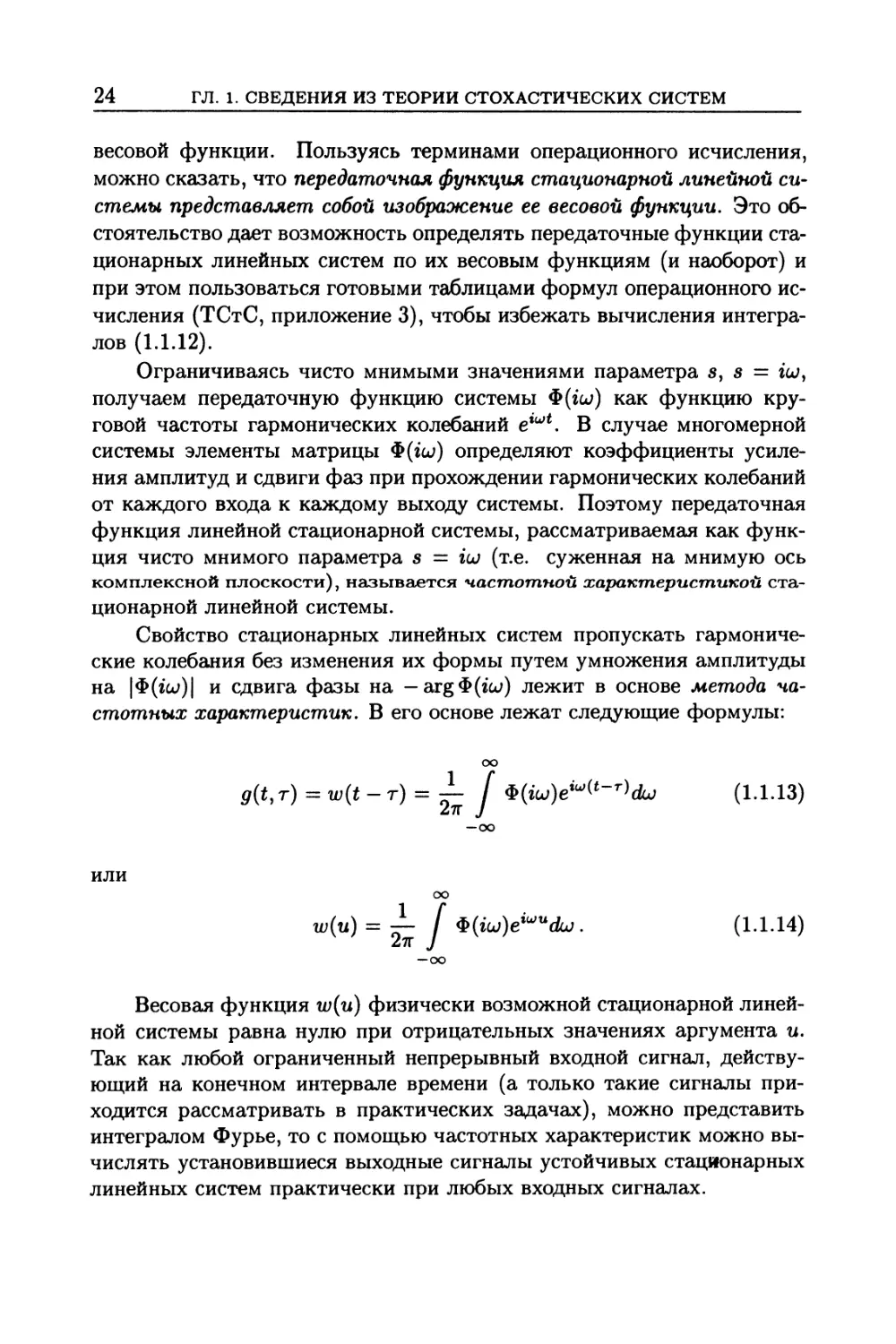

весовой функции. Пользуясь терминами операционного исчисления,

можно сказать, что передаточная функция стационарной линейной си-

стемы представляет собой изображение ее весовой функции. Это об-

стоятельство дает возможность определять передаточные функции ста-

ционарных линейных систем по их весовым функциям (и наоборот) и

при этом пользоваться готовыми таблицами формул операционного ис-

числения (ТСтС, приложение 3), чтобы избежать вычисления интегра-

лов (1.1.12).

Ограничиваясь чисто мнимыми значениями параметра s, s = icu,

получаем передаточную функцию системы Ф(гси) как функцию кру-

говой частоты гармонических колебаний егиН. В случае многомерной

системы элементы матрицы Ф(гси) определяют коэффициенты усиле-

ния амплитуд и сдвиги фаз при прохождении гармонических колебаний

от каждого входа к каждому выходу системы. Поэтому передаточная

функция линейной стационарной системы, рассматриваемая как функ-

ция чисто мнимого параметра s = ш (т.е. суженная на мнимую ось

комплексной плоскости), называется частотной характеристикой ста-

ционарной линейной системы.

Свойство стационарных линейных систем пропускать гармониче-

ские колебания без изменения их формы путем умножения амплитуды

на |Ф(го>)| и сдвига фазы на — arg Ф (геи) лежит в основе метода ча-

стотных характеристик. В его основе лежат следующие формулы:

оо

g(t,r) =w(t-T) = ^~ [ $(iw)e<u,(‘-T)dw (1.1.13)

27Г J

—оо

ИЛИ

оо

w(u) = -L f . (1.1.14)

27Г J

—оо

Весовая функция w(u) физически возможной стационарной линей-

ной системы равна нулю при отрицательных значениях аргумента и.

Так как любой ограниченный непрерывный входной сигнал, действу-

ющий на конечном интервале времени (а только такие сигналы при-

ходится рассматривать в практических задачах), можно представить

интегралом Фурье, то с помощью частотных характеристик можно вы-

числять установившиеся выходные сигналы устойчивых стационарных

линейных систем практически при любых входных сигналах.

1.1. МАТЕМАТИЧЕСКИЕ МОДЕЛИ СИСТЕМ И ИХ ХАРАКТЕРИСТИКИ 25

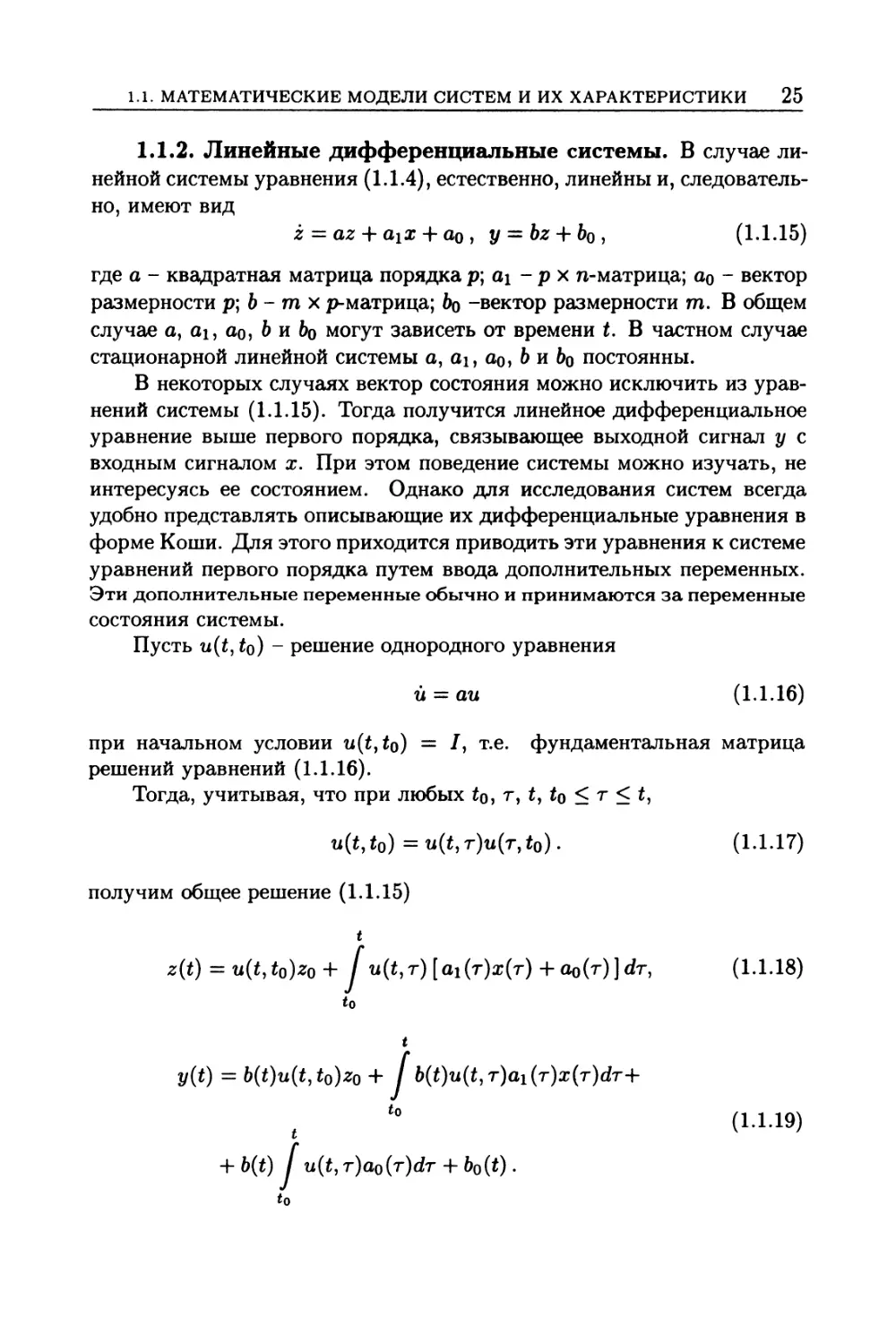

1.1.2. Линейные дифференциальные системы. В случае ли-

нейной системы уравнения (1.1.4), естественно, линейны и, следователь-

но, имеют вид

z — az + а^х + ао , = + (1.1.15)

где а - квадратная матрица порядка р; ai - р х n-матрица; ао ~ вектор

размерности р; b - тп х р-матрица; 6о -вектор размерности тп. В общем

случае а, ах, ао, Ь и &о могут зависеть от времени t. В частном случае

стационарной линейной системы a, ai, ao, Ь и &о постоянны.

В некоторых случаях вектор состояния можно исключить из урав-

нений системы (1.1.15). Тогда получится линейное дифференциальное

уравнение выше первого порядка, связывающее выходной сигнал у с

входным сигналом х. При этом поведение системы можно изучать, не

интересуясь ее состоянием. Однако для исследования систем всегда

удобно представлять описывающие их дифференциальные уравнения в

форме Коши. Для этого приходится приводить эти уравнения к системе

уравнений первого порядка путем ввода дополнительных переменных.

Эти дополнительные переменные обычно и принимаются за переменные

состояния системы.

Пусть u(t, to) - решение однородного уравнения

й = аи (1.1.16)

при начальном условии u(t,to) = I, т.е. фундаментальная матрица

решений уравнений (1.1.16).

Тогда, учитывая, что при любых to> т, t, to <т < t,

u(t, to) = a(t, t)u(t, to). (1.1.17)

получим общее решение (1.1.15)

t

z(t) = u(t,to)zQ + У u(t,r) [ai(r)z(r) + ao(r)]dT, (1.1.18)

to

t

y(t) = b(t)u(t,to)zo + У 5(f)u(f,T)ai(r)a:(T)dT+

( ‘° (1-1.19)

+ b(t) У u(t, т)ао(т)4т 4- &o(O •

to

26

ГЛ. 1. СВЕДЕНИЯ ИЗ ТЕОРИИ СТОХАСТИЧЕСКИХ СИСТЕМ

Отсюда видно, что рассматриваемая система (1.1.15) представляет со-

бой линейную систему с аддитивным дополнительным выходным сиг-

налом

t

Уо(*) = tQ)zQ + b(t) / u(t, т)ао(т)(1т + bQ(t) (1.1.20)

to

и весовой функцией

g(t, т) = b(t)u(t, r)ai (т)1(£ - т), (1.1.21)

где l(s) - единичная ступенчатая функция, равная 1 при s > 0 и 0

при s < 0. Формула (1.1.21) показывает, что весовая функция линей-

ной дифференциальной системы легко находится, если известна фун-

даментальная матрица решений соответствующего однородного урав-

нения (1.1.16).

Для нахождения передаточной функции стационарной линейной

системы, описываемой уравнениями (1.1.15), необходимо: положить

а0 = 0, Ьо = 0, вместо каждой компоненты входного сигнала Xh по

очереди подставить в (1.1.15) показательную функцию e8t, а вместо вы-

ходного сигналаг/ подставить функцию Ф/1(«)е4’^, где Ф/1(§) - Л-й столбец

матричной передаточной функции системы Ф($) (Л = 1, ... , п). При

этом следует положить z = Фь^е8*. Сократив полученные уравнения

на sst, найдем Ф/^з) и Ф/1(«). Однако проще найти Ф/^з) и Ф/^з), поло-

жив в (1.1.15) х = Ie8t, у — $e8t, z = Ф($)е5*. В результате получим

Ф($) = —(а - sl)-1^ , ф(5) = -Ь(а - sl)"1^ . (1.1.22)

Отсюда видно, что передаточная функция стационарной линейной си-

стемы, описываемой дифференциальными уравнениями (конечно, ли-

нейными с постоянными коэффициентами), представляет собой ра-

циональную функцию комплексной переменной s.

1.1.3. Соединения систем и их характеристики

Соединения систем. Каждая сложная система состоит из ряда

более простых систем, взаимодействующих между собой определенным

образом. В зависимости от характера взаимодействия они могут быть

связаны между собой различными способами. Основными типами со-

единений простых систем в сложных системах являются последователь-

ное соединение, параллельное соединение и обратная связь.

1.1. МАТЕМАТИЧЕСКИЕ МОДЕЛИ СИСТЕМ И ИХ ХАРАКТЕРИСТИКИ 27

Последовательным соединением систем называется такое соедине-

ние, когда выход каждой системы связывается с входом следующей си-

стемы, т.е. когда выходная переменная каждой системы служит вход-

ной переменной для следующей системы. При этом предполагается, что

соединяемые системы обладают направленным действием.

Параллельным соединением систем называется такое соединение,

при котором входная переменная подается одновременно на несколько

систем, а их выходные переменные суммируются.

Обратной связью называется соединение выхода системы с ее вхо-

дом. Если выходная переменная системы непосредственно подается на

ее вход без какого-либо преобразования, то обратная связь называется

жесткой. Жесткая обратная связь может быть положительной или

отрицательной в зависимости от того, суммируется выходная перемен-

ная системы с ее входной переменной или вычитается из нее. Если в

цепь обратной связи включена некоторая система, преобразующая вы-

ходную переменную основной системы, то такая обратная связь назы-

вается гибкой.

Для удобства мы всегда будем рассматривать отрицательную гиб-

кую обратную связь, что, очевидно, не нарушает общности, так как пе-

ремену знака всегда можно включить в преобразование, выполняемое

системой, включенной в цепь обратной связи. Очевидно, что жесткую

обратную связь можно рассматривать как частный случай гибкой об-

ратной связи, когда система, включенная в цепь обратной связи, пред-

ставляет собой идеальную следящую систему (отрицательная жесткая

обратная связь) или безынерционное усилительное звено с коэффици-

ентом усиления, равным —1 (положительная жесткая обратная связь).

Применяемые на практике методы описания систем в виде операто-

ров, весовых, передаточных, частотных и других описывающих функ-

ций позволяют строить удобные графические представления математи-

ческих моделей линейных систем, которые сами могут рассматриваться

как изобразительные модели, эквивалентные аналитическим. Обычно

выделяют два вида графических моделей: структурные схемы и графы.

Структурной схемой называется графическое изображение

структуры системы или ее части. При этом под структурой понима-

ется совокупность частей и связей, изображающих каналы, по которым

передаются воздействия от одной части к другой. Элементами струк-

турной схемы являются:

• Линейные динамические звенья, изображаемые прямоугольника-

ми, которым соответствуют операторы, описывающие функции, про-

ставляемые на схеме или в прилагаемом описании.

28

ГЛ. 1. СВЕДЕНИЯ ИЗ ТЕОРИИ СТОХАСТИЧЕСКИХ СИСТЕМ

• Безынерционные функциональные преобразователи, также

изображаемые прямоугольными, которым соответствуют безынерцион-

ные линейные и нелинейные преобразования.

• Сумматоры, изображаемые разделенными на секторы кру-

жочками; к некоторым секторам подходят стрелки, изображающие сла-

гаемые, а от других, наоборот, отходят стрелки, изображающие сумму.

Вообще сумматоры реализуют алгебраическое сложение и для удобства

операций сложения и вычитания обычно отмечаются соответствующи-

ми знаками у концов стрелок или зачеркиванием секторов, в которых

осуществляется вычитание. Наконец, иногда просто в кружочках пока-

зывают знаками +, — соответствующие операции.

• Связи, передающие воздействия без изменения, изображаемые

прямыми линиями со стрелками, указывающими направление воздей-

ствия. Такими же линиями со стрелками изображаются сами воздей-

ствия.

• Узлы или точки разветвления на линиях связи; значения пере-

менных на стрелках, подходящих к узлу и отходящих от него, равны

между собой.

В настоящее время наметилась тенденция к использованию на-

правленных графов. Элементами графа служат отрезок линии - дуга

или ребро, которому сопоставляется оператор, описывающая функция,

безынерционный функциональный преобразователь и пара изображае-

мых кружками вершин на концах ребра, которым сопоставляются зна-

чения входной и выходной величин. Направления передачи воздействия

на графе отмечаются соответствующими стрелками. От вершины мо-

гут исходить несколько ребер, в этом случае входные величины для всех

отходящих ребер одинаковы. Направленные графы в отличие от струк-

турных схем не требуют специальных обозначений для сумматоров и

точек разветвления и все графы изображаются с помощью лишь трех

элементов: ребер, вершин и стрелок.

Правила преобразований структурных схем и графов ли-

нейных систем. Часто бывает полезно структурную схему преобразо-

вать к более удобному для исследования виду путем расчленения слож-

ных систем на более простые (декомпозиция), объединения простых си-

стем в одну (агрегирование) и различных преобразований с целью упро-

щения структуры при сохранении числа и порядка входящих систем.

Основной принцип структурных преобразований состоит в том, что

все преобразования структурной схемы линейной системы и, в частно-

сти, перестановки соседних элементов, агрегирование и декомпозиция

нескольких последовательно (параллельно) соединенных систем, пред-

1.1. МАТЕМАТИЧЕСКИЕ МОДЕЛИ СИСТЕМ И ИХ ХАРАКТЕРИСТИКИ 29

ставление системы и замыкающей ее обратной связи одной системой и,

наоборот, декомпозиции сложной системы на более простую, замкну-

тую обратной связью должны производиться так, чтобы все входные и

выходные сигналы каждого преобразуемого участка схемы оставались

неизменными. Основные правила структурных преобразований произ-

вольных линейных систем приведены (ТСтС, п.1.3.7).

Весовые функции соединений линейных систем. Весовая

функция двух последовательно соединенных систем определяется фор-

мулой

t

g{t,r) = У (1.1.23)

Г

Рассмотрим теперь параллельное соединение линейных систем,

имеющих известные весовые функции д\ и р2- При параллельном со-

единении линейных систем их весовые функции суммируются'.

g(t,r) = gi(t,r) +£2(*,т). (1.1.24)

Весовые функции двух взаимно обратных линейных систем удовлетво-

ряют двум интегральным соотношениям

оо оо

g~(t, a)g(a, г) da = 6(t — т), J* g(t,a)g~ (а^т) da = 6(t — r). (1.1.25)

—oo —oo

Системой, обратной по отношению к системе с обратной связью,

является параллельное соединение системы, обратной по отношению к

системе, стоящей в прямой цепи, и системы, стоящей в цепи обратной

связи. Таким образом, последовательное соединение этих систем дает

идеальную следящую систему. Такие системы являются взаимно обрат-

ными. Применяя формулу (1.1.24) для весовой функции параллельного

соединения линейных систем, находим

p~(t,r) =9i(t,r) +g2(t,T). (1.1.26)

Соединения стационарных линейных систем. Рассмотрим

сначала последовательное соединение двух стационарных линейных си-

стем с передаточными функциями Ф1($) и Фг(з). Тогда, последователь-

ное соединение стационарных линейных систем дает стационарную

30

ГЛ. 1. СВЕДЕНИЯ ИЗ ТЕОРИИ СТОХАСТИЧЕСКИХ СИСТЕМ

линейную систему, передаточная функция которой Ф($) равна произ-

ведению передаточных функций соединяемых систем’.

Ф($) = Ф1($)Ф2($). (1.1.27)

Если передаточные функции п соединяемых последовательно си-

стем равны Ф1($),..., Фп(з), то передаточная функция соединения Ф($)

определяется формулой

п

Ф(«) = Ф1(в)Ф2(5) • • • Фп(в) = П (1Л-28)

к=1

Результат последовательного соединения стационарных линейных си-

стем не зависит от порядка их соединения.

Имеют место следующие формулы для амплитудно- и фазо-частот-

ной характеристик последовательного соединения:

п

|ф(^)| = П 1^(^)1> (1.1.29)

k=l

1g |Ф(гш)| = 1g |Ф*(го>)|, arg Ф (го;) = 57 arg Ф^ (геи). (1.1.30)

к=1 /г—1

При последовательном соединении стационарных линейных сис-

тем их фазо-частотные характеристики и логарифмические ампли-

тудно-частотные характеристики суммируются.

В результате последовательного соединения двух взаимно обрат-

ных стационарных линейных систем получается идеальная следящая

система, передаточная функция которой равна единице. Передаточные

функции двух взаимно обратных стационарных линейных систем яв-

ляются взаимно обратными величинами. Если данная система имеет

передаточную функцию Ф(§), то передаточная функция обратной си-

стемы будет 1/Ф($).

Передаточная функция параллельного соединения стационарных

линейных систем равна сумме передаточных функций соединяемых си-

стем:

Ф($) = Ф1(«) + Ф2(«). (1.1.31)

Эта формула распространяется на любое число параллельно соединен-

ных систем:

п

Ф(а) = £фк(в). (1.1.32)

к=1

1.1. МАТЕМАТИЧЕСКИЕ МОДЕЛИ СИСТЕМ И ИХ ХАРАКТЕРИСТИКИ 31

Рассмотрим систему, состоящую из стационарной линейной систе-

мы с передаточной функцией $i (s), замкнутой отрицательной обратной

связью, содержащей стационарную линейную систему с передаточной

функцией Для определения передаточной функции Ф($) этой

системы рассмотрим обратную систему, которая имеет передаточную

функцию 1/Ф($). Эта обратная система представляет собой параллель-

ное соединение системы с передаточной функцией 1/Ф1 (s) и системы с

передаточной функцией Ф2($). Поэтому, пользуясь формулой (1.1.32),

получаем

*(») ф,(»)+!' Ф,(.)

Отсюда находим передаточную функцию интересующей нас системы с

обратной связью:

ф(” = гттажы- <1133>

При жесткой отрицательной обратной связи в формуле (1.1.33) следует

положить Ф2(«) = 1.

Таким образом, при любых соединениях стационарных линейных

систем всегда получаются стационарные линейные системы, пере-

даточные функции и частотные характеристики которых определя-

ются при помощи элементарных алгебраических действий по данным

передаточным функциям (соответственно частотным характерис-

тикам) соединяемых систем,

1.1.4. Стохастические дифференциальные системы. Стоха-

стические модели систем учитывают действие различных случайных

факторов. При применении моделей, описываемых дифференциальны-

ми уравнениями, учет случайных факторов приводит к уравнениям,

содержащим случайные функции (раздел 1.2).

Дифференциальные уравнения (1.1.4) для стохастической системы

должны быть заменены в общем случае уравнениями

Z = F(Z,x,t), Y = G(Z,t), (1.1.34)

где F(z,x,t) и G(z,t) - случайные функции р-мерного вектора z,

n-мерного вектора х и времени t (при этом, как правило, G от х не зави-

сит). Вследствие случайности правых частей уравнений (1.1.34) и, воз-

можно, также начального значения вектора состояния Zq =

= Z(to) вектор состояния системы Z и выходной сигнал Y в каждый

данный момент t представляют собой случайные величины. Поэтому

мы обозначаем их, так же как и случайные функции в правых частях

32

ГЛ. 1. СВЕДЕНИЯ ИЗ ТЕОРИИ СТОХАСТИЧЕСКИХ СИСТЕМ

уравнений (1.1.34), большими буквами. Рассматриваемые как функции

времени t, вектор состояния системы Z(t) и ее выходной сигнал Y(t)

представляют собой случайные функции времени t (в общем случае век-

торные). В каждом конкретном опыте случайные функции F(z,x,t) и

Gfat) реализуются в виде некоторых конкретных функций f(z,x,t) и

g(z,t) и этим их реализациям соответствуют вполне определенные ре-

ализации z(t), y(t) вектора состояния Z(t) и выходного сигнала

которые, очевидно, определяются дифференциальными уравнениями

(реализациями уравнений (1.1.34)) z = f(z,x,t), у = g(z,t). Таким

образом, мы приходим к необходимости изучать дифференциальные

уравнения со случайными функциями в правых частях.

В том случае, когда все неопределенные величины в правых частях

уравнений можно считать случайными функциями времени, уравнения

(1.1.34) запишутся в виде

Z =/(Z, я, (*),*), Y = g(Z,N2(t),t), (1.1.35)

где f и g - вполне определенные функции, в число аргументов ко-

торых входят случайные функции времени JV’i(t), N2(t). Начальный

вектор состояния системы Zq в практических задачах всегда являет-

ся случайной величиной, независимой от случайных функций Ni(t) и

N2(t) (от действующих на систему случайных возмущений). Каждой

реализации [пх(£)тП2(£)т]Т случайной функции [Nx(*)TN2(t)T]T

соответствуют реализации /(z, я, ni (£),£), g(z,n2(t),t) функций

f(z,x, М(£), t), g(z,N2(t'),t'), и согласно этому уравнения (1.1.35) дают

реализации z(t) и y(t) вектора состояния системы Z(t) и ее выходного

сигнала Y (£).

Линейные стохастические дифференциальные системы.

Дифференциальные уравнения линейной стохастической системы от-

личаются от уравнений детерминированной линейной системы (1.1.15)

дополнительными аддитивными случайными слагаемыми:

Z — aZ 4- d\x 4- clq 4- d2N\(t), Y — bZ 4- 4~ b\N2(t}. (1.1.36)

В этих уравнениях M (t) и N2(t) - случайные функции времени, в общем

случае векторные. Вводя составную векторную случайную функцию

N(t) = [2Vi(t)TN2(£)т]Т и блочные матрицы d2 — [аг 0], Ь[ = [0Ьх ], где

0 означает матрицу, все элементы которой равны нулю, представим слу-

чайные слагаемые в (1.1.36) в виде a2MW = a2N(t), = b2N(t).

Поэтому без потери общности можно отбросить индексы у случайных

функций и записать (1.1.36) в виде

Z = dZ + dYx + a0 4- d2N(t), Y = bZ 4- b0 + bxW(t). (1.1.37)

1.1. МАТЕМАТИЧЕСКИЕ МОДЕЛИ СИСТЕМ И ИХ ХАРАКТЕРИСТИКИ 33

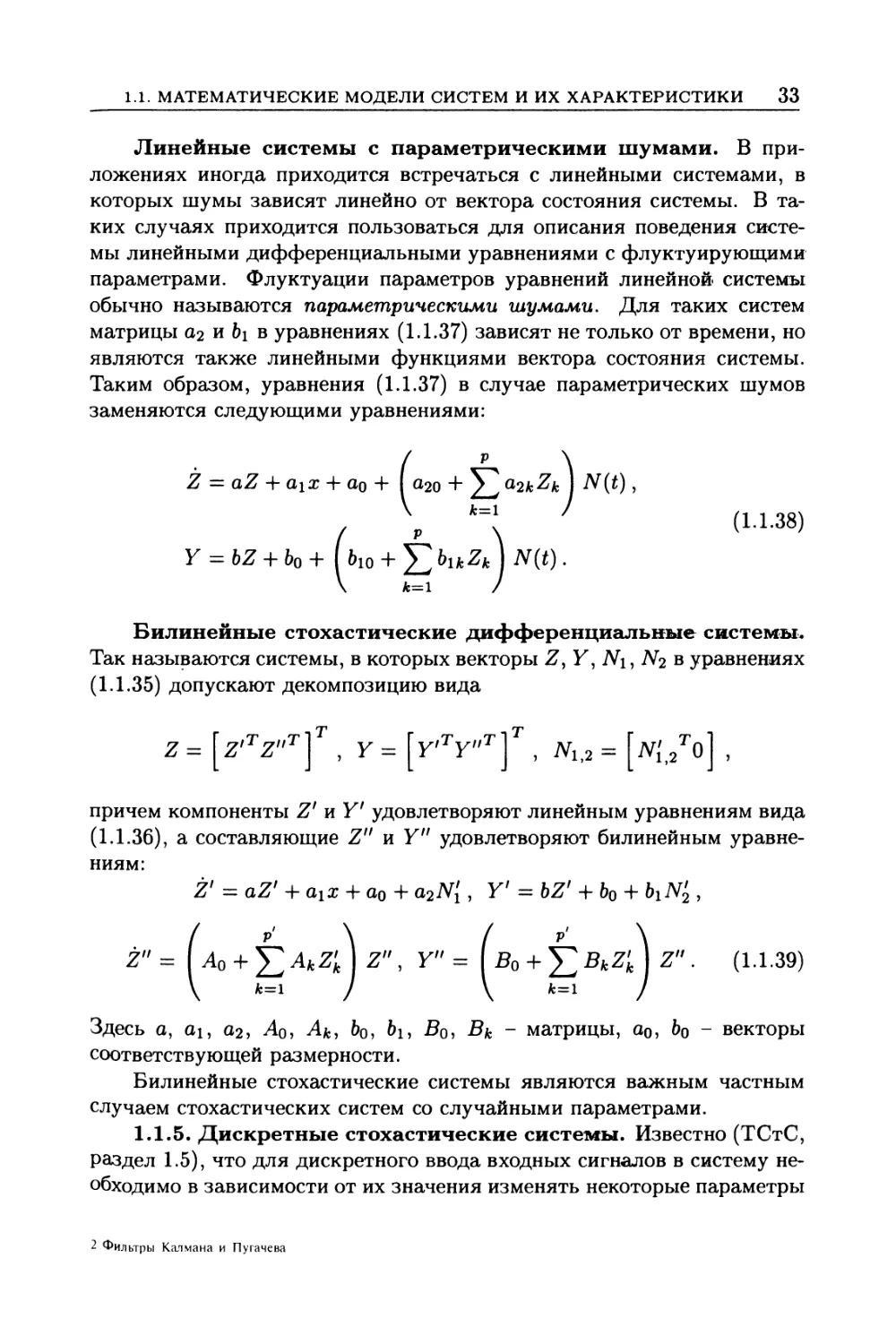

Линейные системы с параметрическими шумами. В при-

ложениях иногда приходится встречаться с линейными системами, в

которых шумы зависят линейно от вектора состояния системы. В та-

ких случаях приходится пользоваться для описания поведения систе-

мы линейными дифференциальными уравнениями с флуктуирующими

параметрами. Флуктуации параметров уравнений линейной системы

обычно называются параметрическими шумами. Для таких систем

матрицы а2 и bi в уравнениях (1.1.37) зависят не только от времени, но

являются также линейными функциями вектора состояния системы.

Таким образом, уравнения (1.1.37) в случае параметрических шумов

заменяются следующими уравнениями:

(р \

0-20 4" a2k^k j Af(£) ,

7 Рк=\ (1Л-38)

Y = bZ + ь0 + ко + X blkZk] N(t).

\ Л=1 /

Билинейные стохастические дифференциальные системы.

Так называются системы, в которых векторы Z, У, М, N2 в уравнениях

(1.1.35) допускают декомпозицию вида

Z = [z,TZ"T]T , Y = [у'ТУ"Т]Т , М,2 = 2То] ,

причем компоненты Z' и У' удовлетворяют линейным уравнениям вида

(1.1.36), а составляющие Z" и Y" удовлетворяют билинейным уравне-

ниям:

Z' — aZ' 4“ Qix 4" do o>2^i , Y1 — bZ1 4" bo 4" biN^ ,

/ p ' \ / p ' \

Z" = Ao + 22 AkZ'k z" > Y" = + 52 BkZ'k Z" (L1-39)

у k=l J у k=l J

Здесь a, ai, 02, Ao? Afc, bo, bi, Bq, Bk - матрицы, Qq, bo - векторы

соответствующей размерности.

Билинейные стохастические системы являются важным частным

случаем стохастических систем со случайными параметрами.

1.1.5. Дискретные стохастические системы. Известно (ТСтС,

раздел 1.5), что для дискретного ввода входных сигналов в систему не-

обходимо в зависимости от их значения изменять некоторые параметры

2 Фильтры Калмана и Пугачева

34

ГЛ. 1. СВЕДЕНИЯ ИЗ ТЕОРИИ СТОХАСТИЧЕСКИХ СИСТЕМ

входных импульсов. Процесс такого изменения называется модуляцией

импульсов входным сигналом. Устройство, формирующее последова-

тельность импульсов, зависящую от входного сигнала, называется им-

пульсным элементом. Обычно форма импульсов сохраняется при мо-

дуляции неизменной. При этом в принципе возможно изменять в зави-

симости от значений входного сигнала один из трех параметров импуль-

са: амплитуду, длительность или момент начала действия импульса. В

соответствии с этим различают три основных вида модуляции импуль-

сов:

• амплитудно-импульсная модуляция (АИМ), при которой

амплитуда импульсов аь линейно зависит от значения входного

сигнала в момент начала действия импульса tk, аь — aktyk) =

= Саим^(^);

• широтно-импульсная модуляция (ШИМ), при которой длитель-

ность импульса Тк линейно зависит от значения входного сигнала в

момент начала действия импульса: Ти(^) = Сшим^(^);

• временная импульсная модуляция (ВИМ), при которой

временной сдвиг Тс (запаздывание) импульса линейно зависит от

значения входного сигнала в определенный момент времени Тс —

— ^вим^(^)-

При АИМ и ШИМ модулирующий сигнал изменяет площадь (т.е.

интенсивность) импульсов, а при ВИМ площадь импульса остается по-

стоянной.

Зависимость модулируемого параметра импульсов, вырабатывае-

мых импульсным элементом от соответствующих дискрет-

ных значений входной переменной, называется характеристикой им-

пульсного элемента. Последняя может быть линейной или нелинейной.

Импульсный элемент с линейной характеристикой является линейным,

а с нелинейной характеристикой - нелинейным.

Импульсные элементы различаются также по форме и характеру

модуляции импульсов, по частоте импульсов и их относительной дли-

тельности. Обычно импульсные элементы работают периоди-

чески, вырабатывая по одному импульсу за каждый период. Период

следования импульсов Тп называется периодом повторения (тактом)

дискретной системы. Величина cjn = ^/Тп представляет собой часто-

ту повторения импульсов. Отношение длительности одного импульса

(средней в случае ШИМ) Ти к периоду повторения импульсов 7 = Т^/Тп

называется относительной длительностью импульсов. Величина 1—7

называется скважностью импульсов элемента.

1.1. МАТЕМАТИЧЕСКИЕ МОДЕЛИ СИСТЕМ И ИХ ХАРАКТЕРИСТИКИ 35

Характеристики дискретных линейных систем. Обозначим

реакцию дискретной линейной системы на кратковременное входное

возмущение, равное единице и действующее только в течение времени

действия к-го импульса, через Qkif). Тогда ее реакция на кратковремен-

ное возмущение, равное x(tk) и действующее только в течение времени