Текст

Р. В. Хэмминг

Теория кодирования

и теория информации

Перевод с английского

С. И. Гельфанда

под редакцией

Б. С. Цыбакова

МОСНВА,

„РАДИО И СВЯЗЬ”

1983

ББК 15.2

Х99

УДК 621.391.251 + 621.391.2

Хэмминг Р. В.

Х99 Теория кодирования и теория информации: Пер. с

англ. — М.: Радио и связь, 1983. — 176 с., ил.

75 к.

Рассматриваются основы теории кодирования и передачи информации.

Описываются свойства источника сообщения и каналов, дается классифи-

кация различных кодов. Особое внимание уделяется помехоустойчивым

-кодам с исправлением и с обнаружением ошибок. Приводятся примеры

использования теории кодирования и теории информации.

Для инженерно-технических работников, специализирующихся в об-

ласти передачи, хранения и обработки информации.

1502000000—094 ББК 15.2

X----------------103—83

046(01)—83 6Ф0.1

Редакция переводной литературы

Richard W. Hamming

Coding and Information Theory

Ричард В. Хэмминг

Теория кодирования и теория информации

Редактор Е. А, Засядько. Обложка художника С. Н. Голубева.

Художественный редактор Р. А. Клочков. Технический редактор Т. Н. Зыкина.

Корректор Я. Г. Зыкова

ИБ № 360

Сдано в набор 28.01.83 г. Подписано в печать 4.04.83 г.

Формат 60X90716 Бумага кн.-журн. Гарнитура литературная Печать высокая

Усл. печ. л. 11,0 Усл. кр.-отт. 11,25 Уч.-изд. л. 11,37 Тираж 7000 экз. Изд. № 20092

Зак. № 19 Цеиа 75 к.

Издательство «Радио и связь». 101000 Москва, Главпочтамт, а/я 693

Типография издательства «Радио н связь» Госкомиздата СССР

101000 Москва, ул. Кирова, д. 40

© 1980 by Prentice-Hall, Inc.

© Перевод на русский язык. Издательство «Радио и связь», 1983

Предисловие редактора перевода ,

Код Хэмминга является самым известным результатом теории

кодирования, а его автор — самым удивительным из ученых, ра-

ботавших в этой области. Дело в том, что Ричард Весли Хэмминг

имеет лишь две .публикации в области теории информации. Одна

из них [1*] содержит конструкцию кода Хэмминга, придуманную

еще до 1948 г., т. е. до появления работы К. Шеннона (i[2*],

с. 289), и, таким образом, представляет собой первую работу по

теории кодирования. Другая — это настоящая книга, вышедшая

30 лет спустя, когда теория кодирования прочно утвердила себя

как сложившееся научное направление. Поэтому появление этой

второй публикации Р. В. Хэмминга является в теории информации

событием незаурядным.

Наши специалисты хорошо знакомы с многими книгами по

теории информации и теории кодирования. Подавляющее боль-

шинство из них написано на высоком математическом уровне. Они

требуют от читателя глубокого знания алгебры и теории случай-

ных процессов, а также определенного уровня математической

культуры. В то же время теория информации — наука приклад-

ная, она служит теоретическим фундаментом техники связи, ра-

диолокации, техники обработки информации. Ее результаты долж-

ны находить практическое применение. Для этого нужно, чтобы

инженеры-проектировщики систем могли понять и оценить резуль-

таты теории. Как этого достичь? Долгое время господствовала

точка зрения, что нужно существенно повысить математическую

подготовку инженеров. Практика, однако, показывает, что выве-

сти математическую подготовку инженеров на требуемый для по-

нимания теоретических трудов уровень пока не удается. Причина

здесь состоит не столько в качестве преподавания или уровне ис-

ходной математической подготовки студентов, сколько в простой

истине: «нельзя объять необъятное» — невозможно совместить в

одном учебном процессе детальную инженерную и глубокую ма-

тематическую подготовку.

Где же искать выход? Нельзя ли пойти в противоположном

направлении и адаптировать теорию информации для инженеров?

Можно ли выделить из теории простые качественные и количест-

венные результаты и методы, существенно не обеднив ее?

Книга Р. В. Хэмминга .представляет собой шаг вперед в этом

(направлении. Она использует самый примитивный и наглядный

математический аппарат и с его помощью, а также с привлечени-

ем качественных рассуждений и интерпретаций пытается дать

представление об основных идеях и достижениях теории.

Чтобы усилить доступность, автор широко использует графиче-

ский материал, численные примеры, гибкую терминологию и под-

робные пояснения выкладок. Однако доступности нигде не прино-

сится в жертву верность результатов или точность интерпрета-

ций. В этом проявляется большое научное и педагогическое даро-

вание автора.

Мы надеемся, что книга Р. В. Хэмминга понравится читателям

и принесет пользу.

Б. С. Цыбаков

Предисловие

Материал книги естественно объединяет теорию кодирования

и теорию информации, которые изучают представления абстракт-

ных символов. В настоящее время эти теории разрослись столь

широко, что в короткой книге можно изложить лишь небольшую

их часть.

Обычно считается, что теория информации рассматривает «пе-

ресылку информации из одного места в другое» (передачу инфор-

мации). Однако эта задача абсолютно аналогична задаче «пере-

сылки информации от одного момента времени до другого» (хра-

нения информации). Обе задачи часто возникают при обработке

информации. Ясно, что кодирование информации для эффективно-

го хранения, а также надежное ее восстановление при наличии

шума очень важны при конструировании ЭВМ.

Поскольку задачи представления, передачи и преобразования

информации весьма существенны во многих областях науки и вы-

числительной техники, важно иметь доступное изложение теории

информации и теории кодирования. Каждый раз, когда появля-

ется необходимость в порождении, хранении или обработке ин-

формации, оказывается нужным знать, как сжать имеющийся

текст и как защитить его от возможных искажений. В книге бу-

дут изложены лишь наиболее существенные из многих известных

методов кодирования, однако можно надеяться, что имеющиеся

в книге многочисленные примеры подготовят читателя к исполь-

зованию других возможных методов.

Цель написания книги — изложить основы двух теорий и при-

вести примеры применения соответствующих идей на практике.

Необходимые предварительные знания математики и радиотехни-

ки сведены к минимуму. Используются лишь основы анализа и

теории вероятностей, а все выходящее за эти рамки приводится

с подробными объяснениями по мере необходимости. Для упроще-

ния изложения и доказательств многих результатов используются

методы, недавно развитые в вычислительной технике. Эти методы

объясняются по мере их использования, так что не предполагается

наличия у читателя предварительных знаний вычислительной тех-

ники. Многие другие доказательства были существенно упроще-

ны и иногда, следуя за развитием технологии, был добавлен но-

вый материал. Предприняты значительные усилия изложить ма-

териал (в особенности доказательство основной теоремы Шенно-

на) таким образом, чтобы было понятно, почему теоремы справед-

ливы, а не только чтобы привести математически строгое доказа-

тельство.

В гл. 1'1, посвященной алгебраическим кодам, приведены не-

обходимые математические результаты, относящиеся к конечным

полям. Ввиду сложности этих результатов глава помещена в ко-

нец книги и несколько выпадает из логически естественного по-

рядка изложения материала. При желании ее можно читать пос-

ле г.л. 3. В тексте часто допускаются повторения; важные идеи

рассматриваются по меньшей мере дважды с тем, чтобы читатель

лучше их усвоил.

В книге не затрагиваются многие важные вопросы; при этом

автор исходил из того, что лучше как следует изучить часть ма-

териала, чем сказать понемногу о многом. Таким образом, лектор

может по своему усмотрению многое добавить к изложенным воп-

росам, если он считает, что это будет полезно слушателям.

В книге используются обычные названия «коды Хэмминга» и

«расстояние Хэмминга»; использование здесь других терминов

было бы проявлением ложной скромности и лишь запутало чи-

тателя.

Автору трудно вспомнить все, чем он обязан другим, поскольку большинство

изложенных в книге фактов он узнал за годы работы в научно-исследователь-

ском отделе фирмы Bell. Чтение лекций в Высшем Военно-морском училище,

основанных на небольшой элегантной книге Н. Абрамсона «Теория информации

и кодирование» [1], снова пробудила интерес автора к этим вопросам. Во вре-

мя чтения различных коротких курсов по этим вопросам возникли многие упро-

щения, уточнения и примеры; автор благодарен многим своим слушателям за

помощь. Особенно существенной была помощь Альберта Вонга.

В процессе написания книги были составлены ее различные варианты на

ЭВМ фирмы Bostrom Management Corp., при этом весьма существенной была

помощь Ральфа Джонса. Однако, как обычно, ответственность за все ошибки

несет автор.

Р. В. Хэммииг

Глава1

Введение

1.1. Краткая аннотация

Хотя в книге используются такие красивые слова как инфор-

мация, передача и кодирование, при более близком рассмотрении

оказывается, что они в действительности представляют лишь ис-

точник сообщений с символами sb sq. Вначале ни о самих сим-

волах, ни о смысле, который в них может содержаться, ничего не

говорится. Предполагается только, что они однозначно разли-

чимы.

Далее вводятся вероятности рь ..., pq появления символов.

Вопрос о том, как найти Pi, в абстрактную теорию не входит. Для

каждого дискретного распределения вероятностей определено зна-

ет

чение энтропии Д—X p,log(l/pi). Функция Н, зависящая от рас-

i=i

пределения вероятностей pi, измеряет количество неопределенно-

сти, неожиданности или информации, содержащееся в распреде-

лении. Эта функция играет основную роль в теории и дает ниж-

нюю границу для средней длины кода. В дальнейшем также рас-

сматриваются более сложные вероятностные структуры, связан-

ные с символами s,.

Проблема представления символов алфавита источника st с

помощью другой системы символов (обычно двоичной, состоящей

из символов 0 и 1) составляет основную тему книги. Она сводит-

ся к следующим двум главным задачам.

1. Требуется представить символы источника так, чтобы их

представления были в некотором смысле далеки друг от друга.

В результате, несмотря на небольшие изменения (шум) этих пред-

ставлений, изменившиеся символы могут быть опознаны как не-

правильные и, возможно, даже исправлены.

2. Для повышения эффективности требуется представить сим-

волы источника в некоторой минимальной форме. Тогда миними-

Q

зируется средняя длина кода L= X рЛ, где — длина представ-

i=i

ления i-ro символа Sj. Энтропия дает нижнюю границу для L.

Таким образом, по существу, это — аострактнаяматематиче-

ская теория представления символов произвольного источника с

помощью заданного алфавита (обычно двоичного). В этой теории

нет передачи, хранения информации, шума, добавляемого к сиг-

налу. Все это лишь красивые слова, используемые для мотивиров-

ки теории. Будем продолжать использовать их, но читатель не

должен обманывать себя — предлагаемая теория является лишь

теорией представления символов.

1.2. История

Теория кодирования и теория информации возникли очень дав-

но. Многие главные идеи были понятны задолго до 1948 г., когда

возникла прочная основа для этих двух теорий. В 4948 г. Клод Е.,

Шеннон опубликовал в Bell System Technical Journal две статьи,

озаглавленные «Математическая теория связи» (перепечатаны в

[14]). Они почти сразу же сделали теорию информации широко

известной, и скоро в журналах появились статьи по теории ин-

формации, а на электротехнических и других факультетах различ-

ных университетов началось чтение лекции по этой дисциплине.

Для теории информации, что типично для внезапно возникающих

научных направлений, большинство первых приложений оказа-

лось неудачным, однако по-другому, видимо, невозможно устано-

вить границы применяемости новой теории. В результате того,

что от теории информации ожидалось больше, чем она могла

дать, наступило разочарование и сокращение числа читаемых кур-

сов. Сейчас можно, вероятно, дать более справедливую оценку

теории, находящуюся где-то между сильным энтузиазмом первых

дней и последующим разочарованием.

Теория информации устанавливает границы того, что можно

сделать, однако мало помогает при проектировании конкретных

систем. Делающийся отсюда вывод о бесполезности теории инфор-

мации является, как показывает следующая аналогия, неверным.

Рассмотрим теорию эволюции, которую предлагают студентам-

биологам. Хотя лишь очень немногим из студентов удастся при-

менять ее в течение жизни, эта теория может служить источником

ценных идей. Несмотря на отсутствие непосредственных примене-

ний, идеи теории эволюции могут быть плодотворно использова-

ны в других часто весьма далеких от биологии ситуациях, в кото-

рых имеются 1) небольшие изменения составных частей (откло-

нения); 2) выживание наиболее приспособленных (отбор).

При рассмотрении какого-либо учреждения, например, факуль-

тета вычислительной математики, университета, военной организа-

ции, банка, правительства или даже семьи, • возникают вопросы:

«Как возникла данная ситуация?» и «Какие силы обеспечили вы-

живание данной конкретной структуры?»

При более глубоком понимании силы теории возникают вопро-

сы: «Какие изменения в учреждении возможны при данной расста-

новке сил?» и «Как оно будет эволюционировать (что именно вы-

живет)?» Таким образом, идеи теории эволюции могут быть ис-

пользованы в ситуациях, весьма далеких от биологии.

Точно так же ряд идей теории информации можно применить

в ситуациях, весьма далеких от тех, которые в ней рассматрива-

ются. Применимость идей не всегда удается точно проследить •—

часто они лишь наводят на некоторую мысль — однако сами идеи

весьма полезны.

Примерно в то же время и в том же месте, что и теория ин-

формации, возникла теория кодирования. Однако публикация ос-

новной работы была задержана по патентным соображениям до

апреля 1950 г., статья появилась опять в Bell System Technical

Journal (перепечатана в [3, 4]). В теории кодирования математи-

ческие основы не столь сложны, как в теории информации, и по-

этому в течение долгого времени она не была столь же привлека-

тельной для теоретиков. Однако по прошествии времени в теории

кодирования начали применяться различные разделы математики,

такие как теория групп, теория конечных полей (теория Галуа) и

даже линейное программирование. В результате, к настоящему

времени теория кодирования стала активно развивающейся об-

ластыф математики [2, 8, 11, 12, 16].

В большинстве областей знания ошибки играют второстепен-

ную роль; они проявляются лишь на более поздних этапах иссле-

дования. Однако в теории кодирования и теории информации

ошибкам (шумам) отводят центральную роль. Поэтому эти тео-

рии особенно интересны, поскольку в реальной жизни шум при-

сутствует всюду.

С точки зрения логики теория .кодирования приводит к теории

информации, и теория информации определяет границы того, что

можно достичь подходящим методом кодирования информации.

Таким образом, обе теории тесно связаны между собой, хотя в

прошлом их развитие шло в значительной мере независимо. Одна

из основных целей написания данной книги — показать взаимо-

связь этих теорий. Более подробно история развития теории коди-

рования изложена в [3].

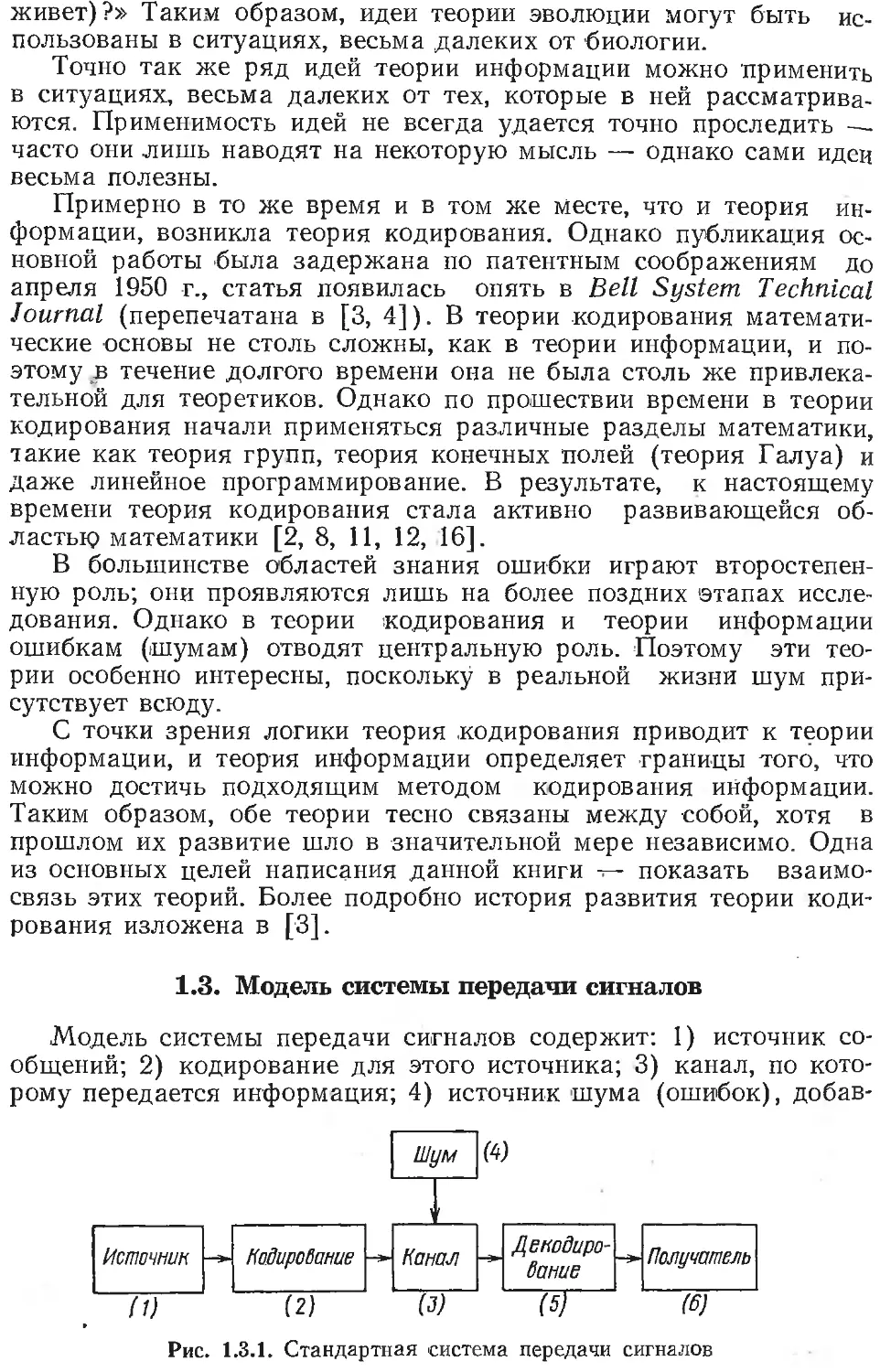

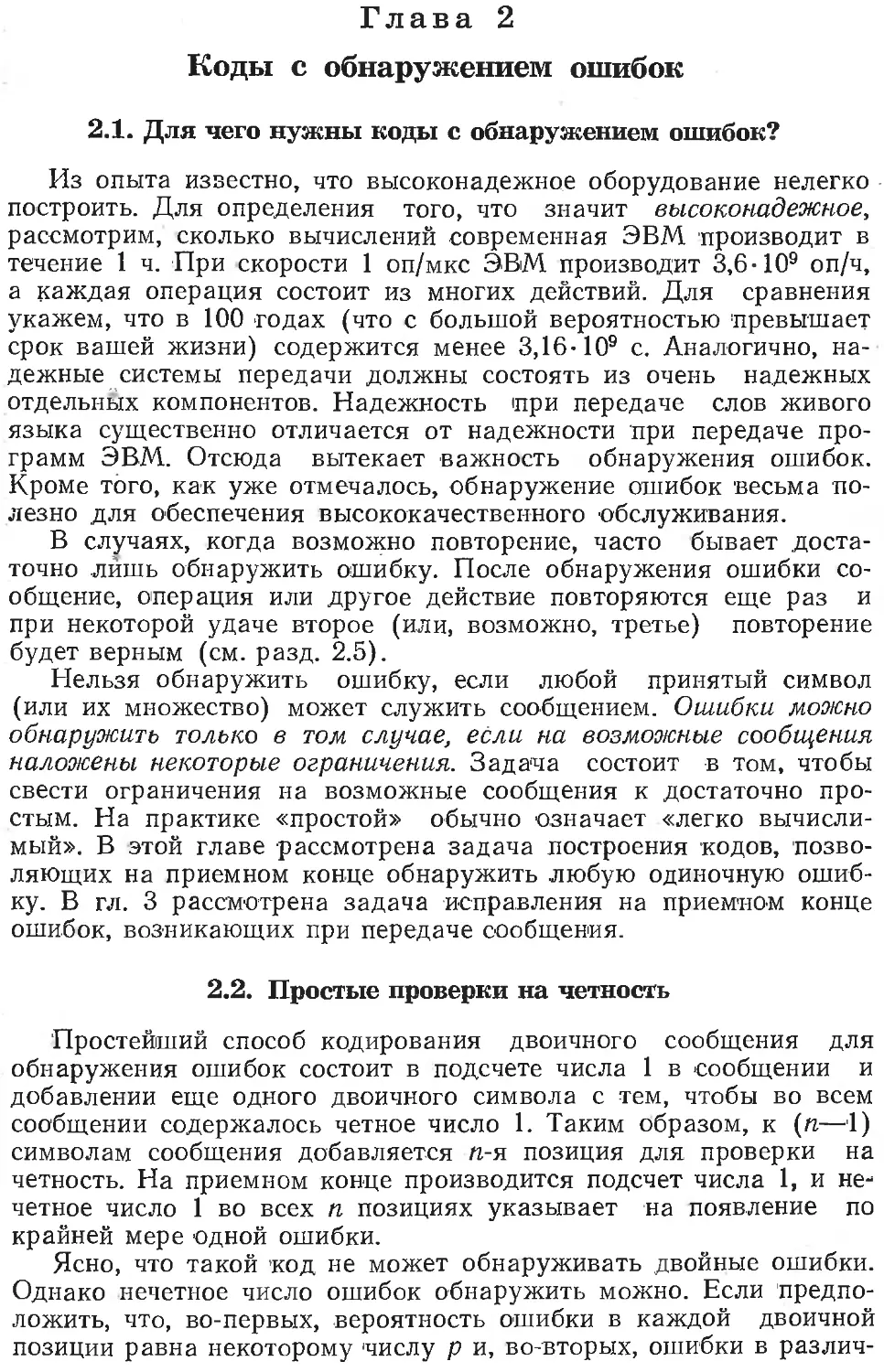

1.3. Модель системы передачи сигналов

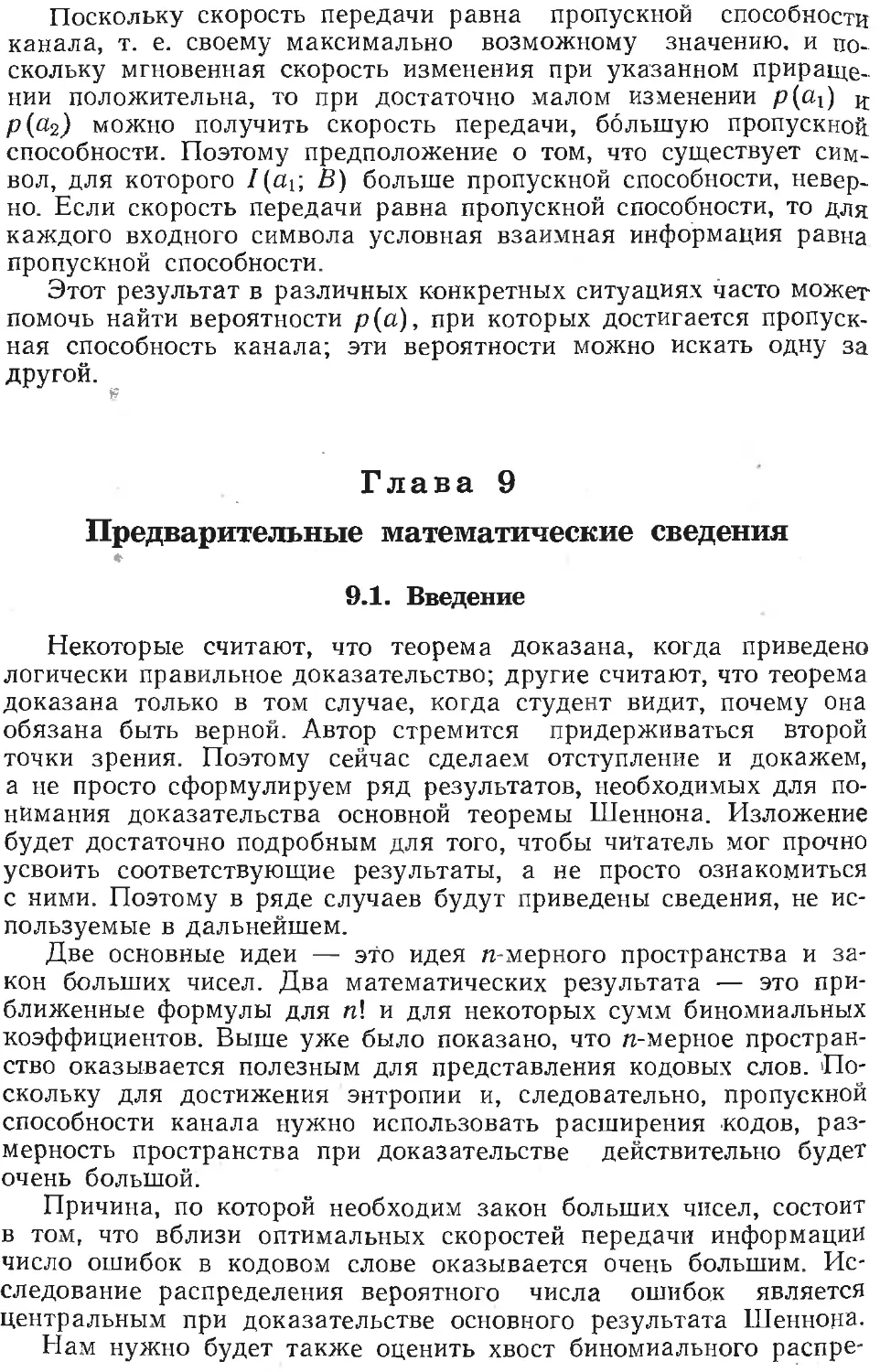

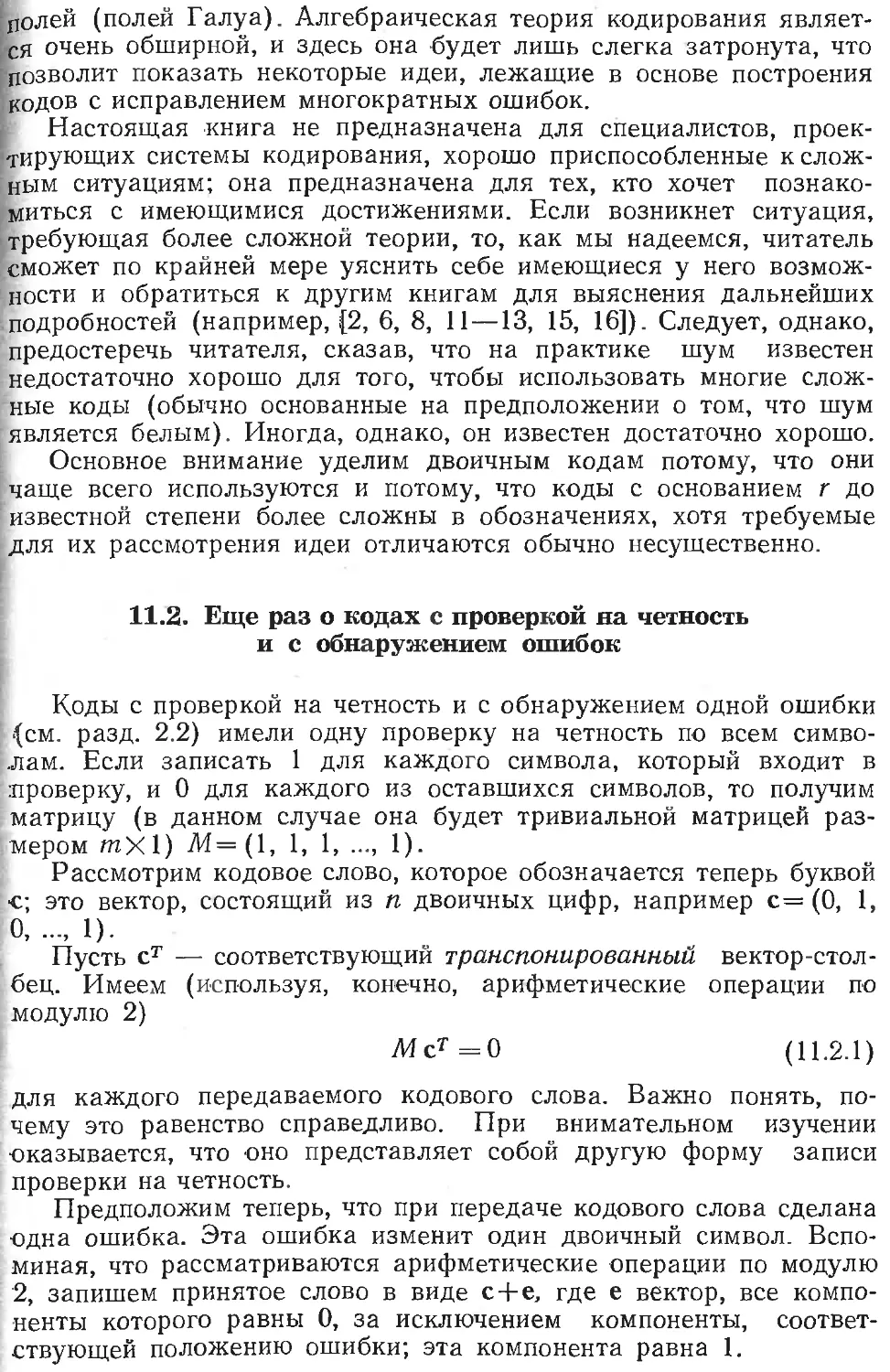

Модель системы передачи сигналов содержит: 1) источник со-

общений; 2) кодирование для этого источника; 3) канал, по кото-

рому передается информация; 4) источник шума (ошибок), добав-

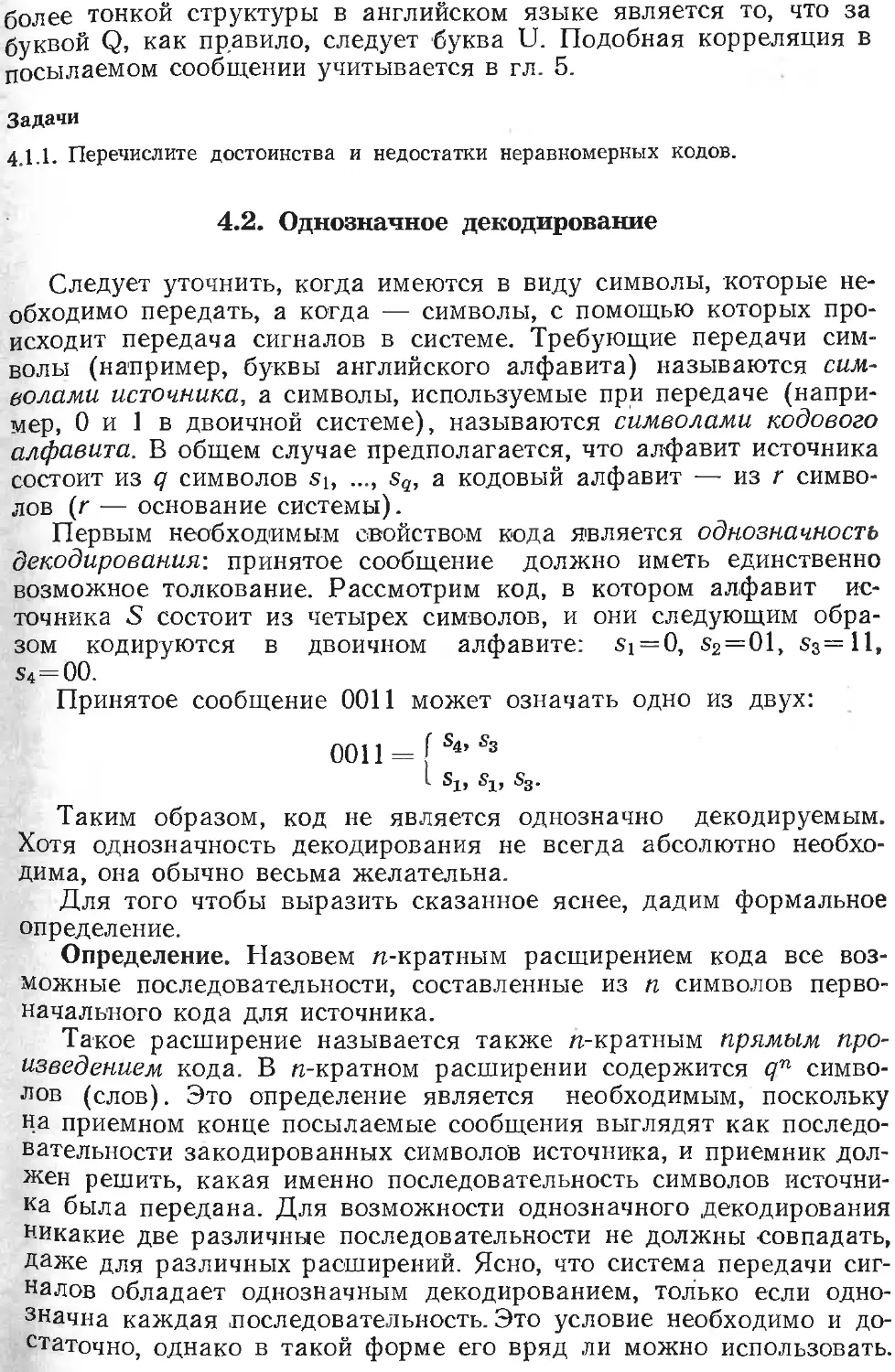

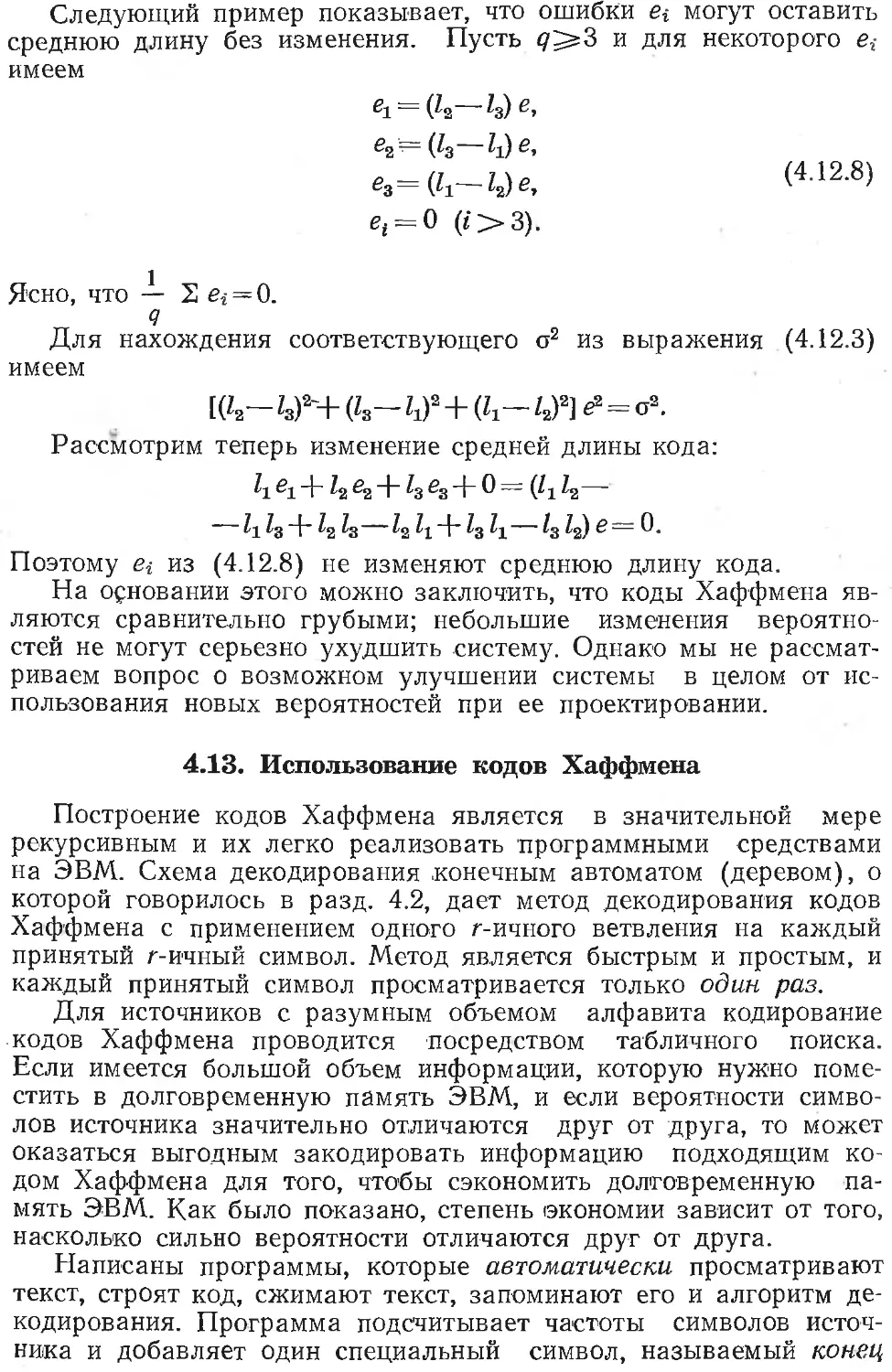

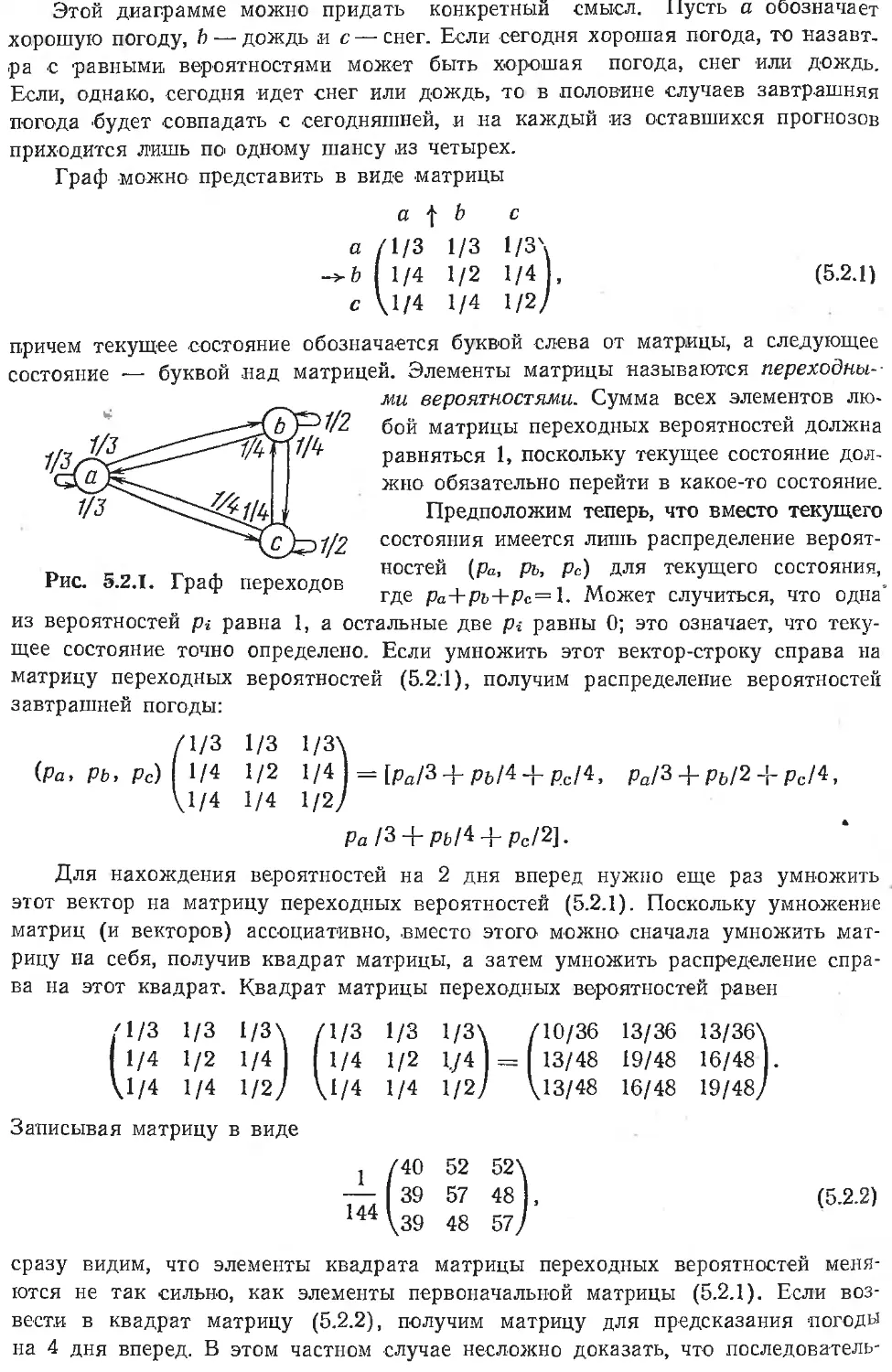

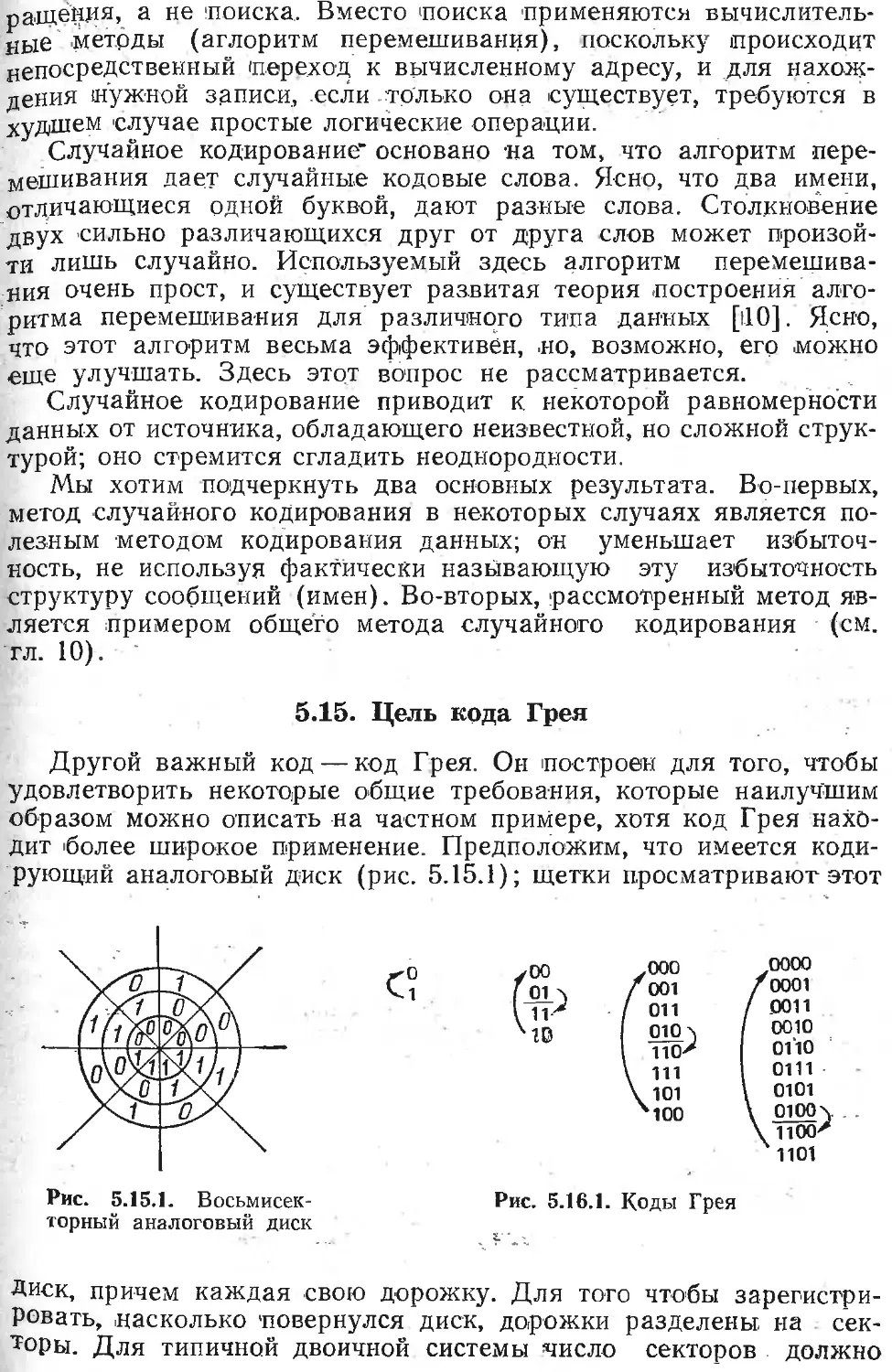

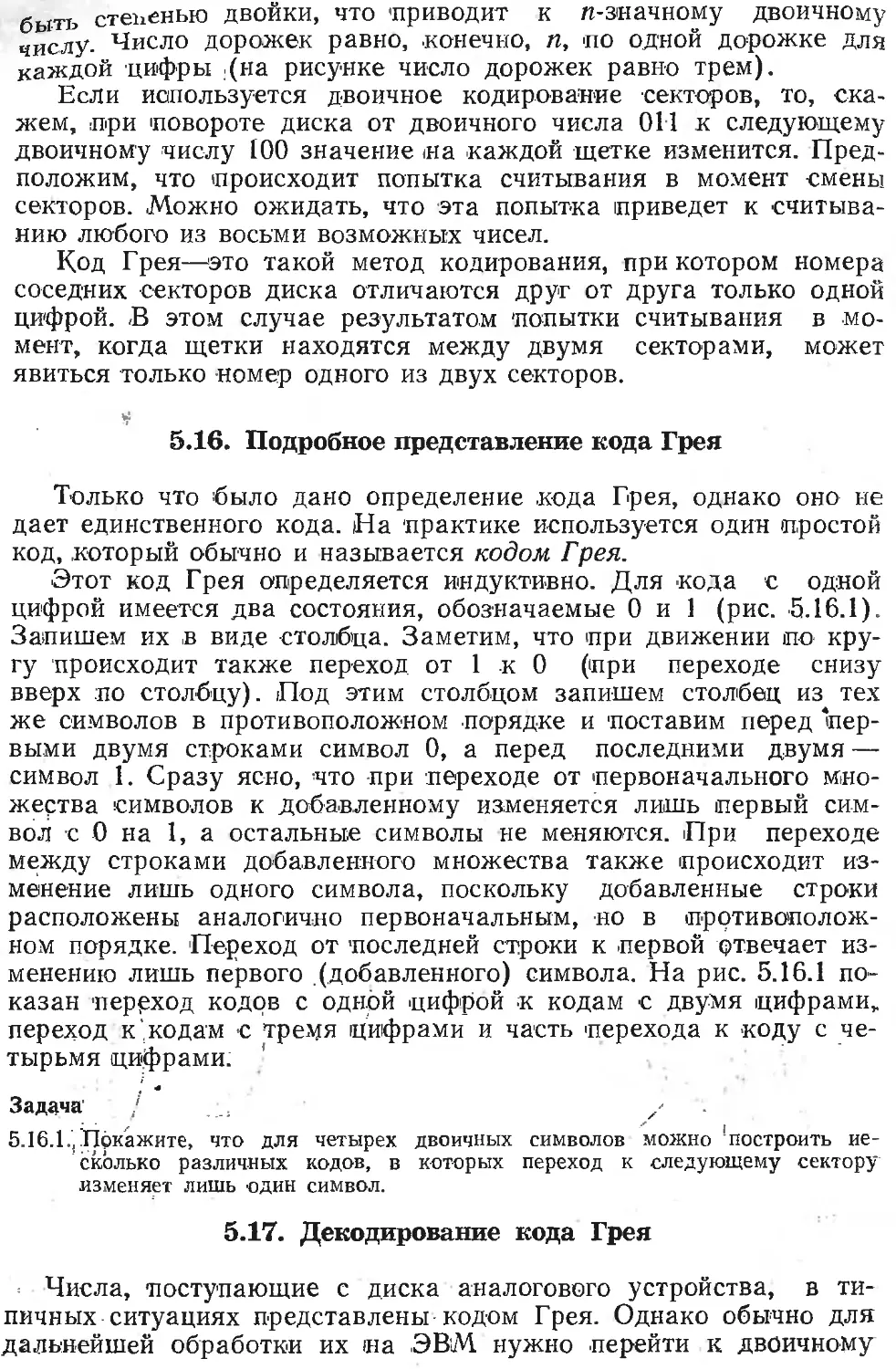

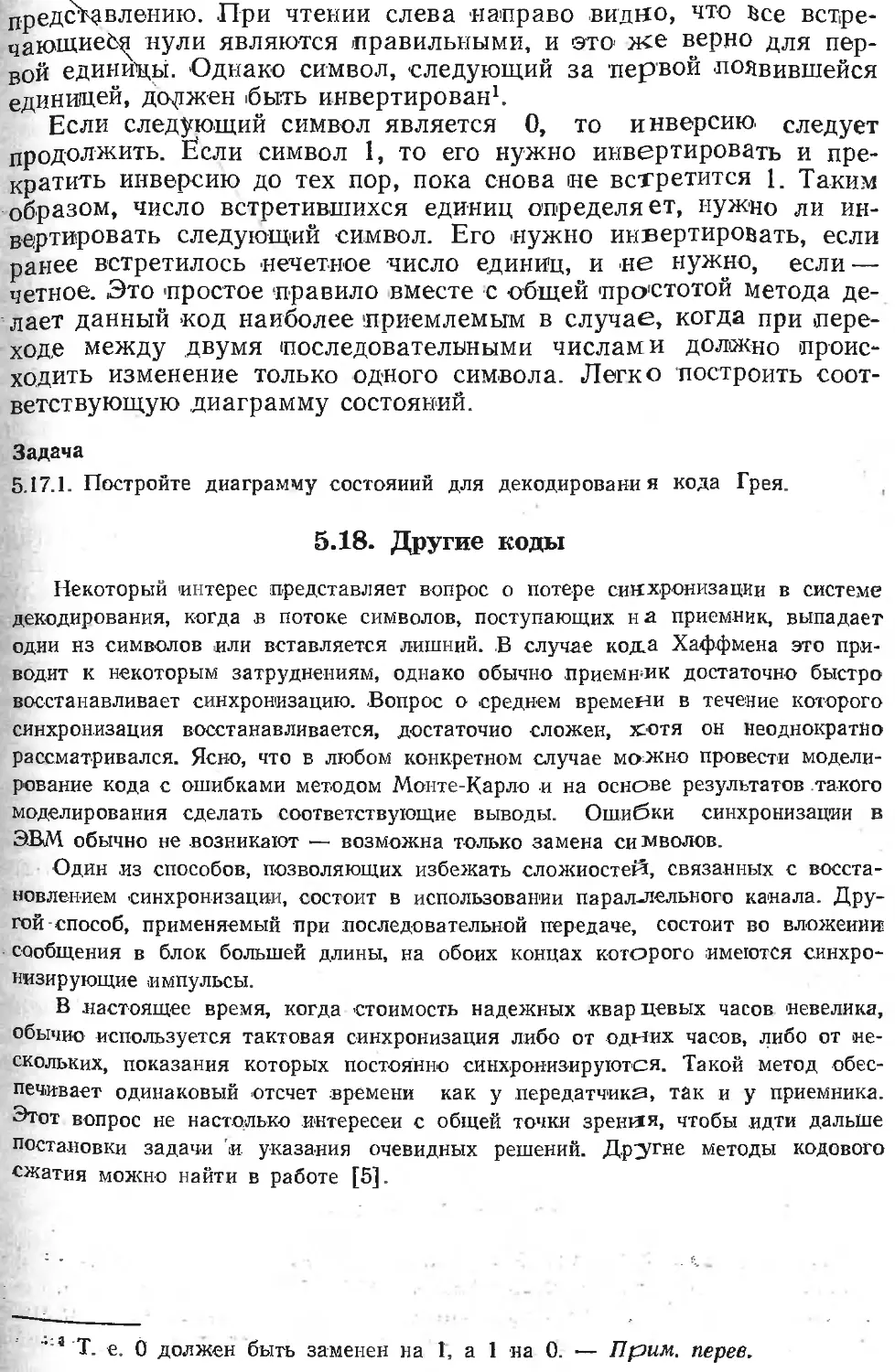

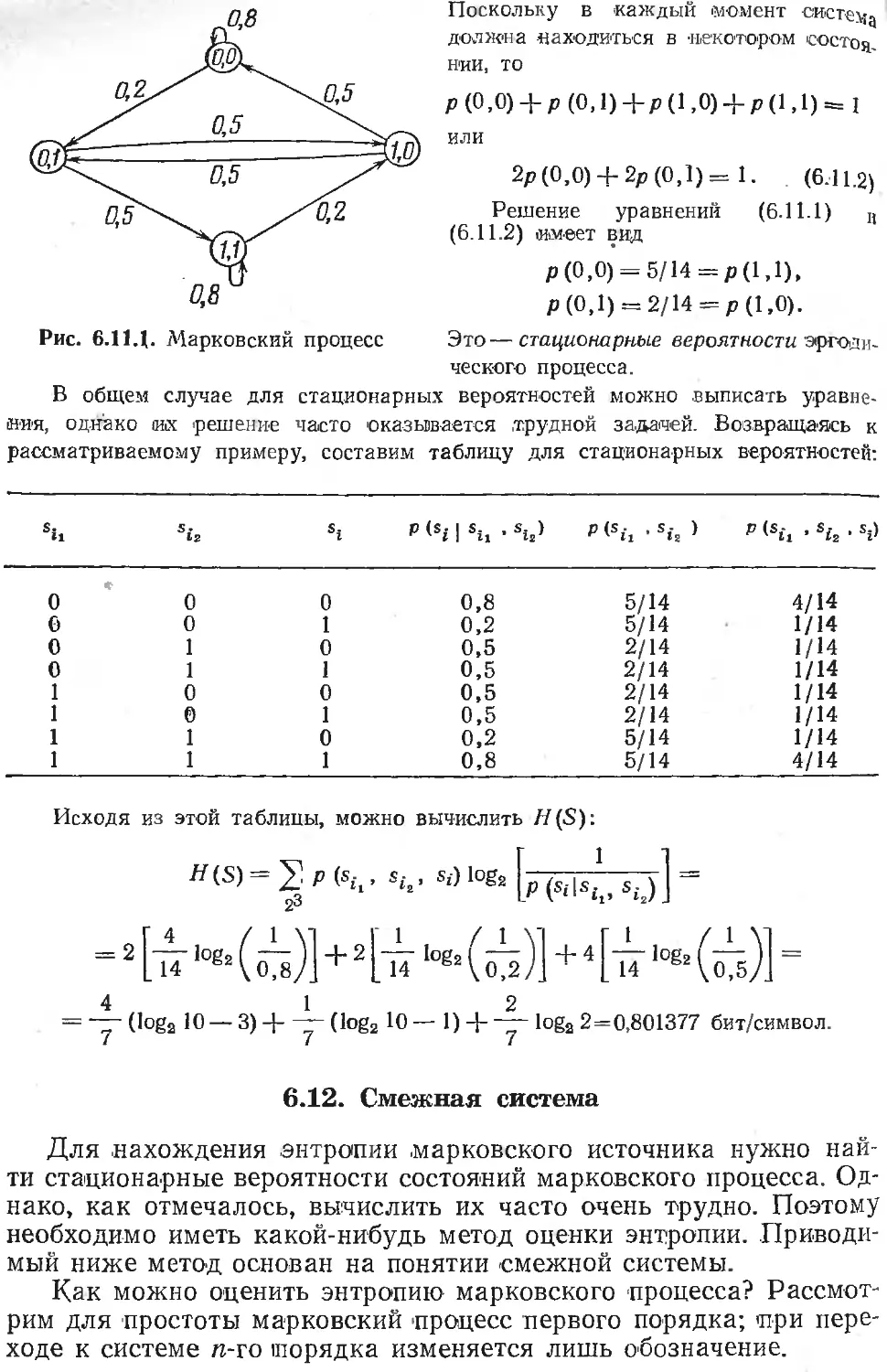

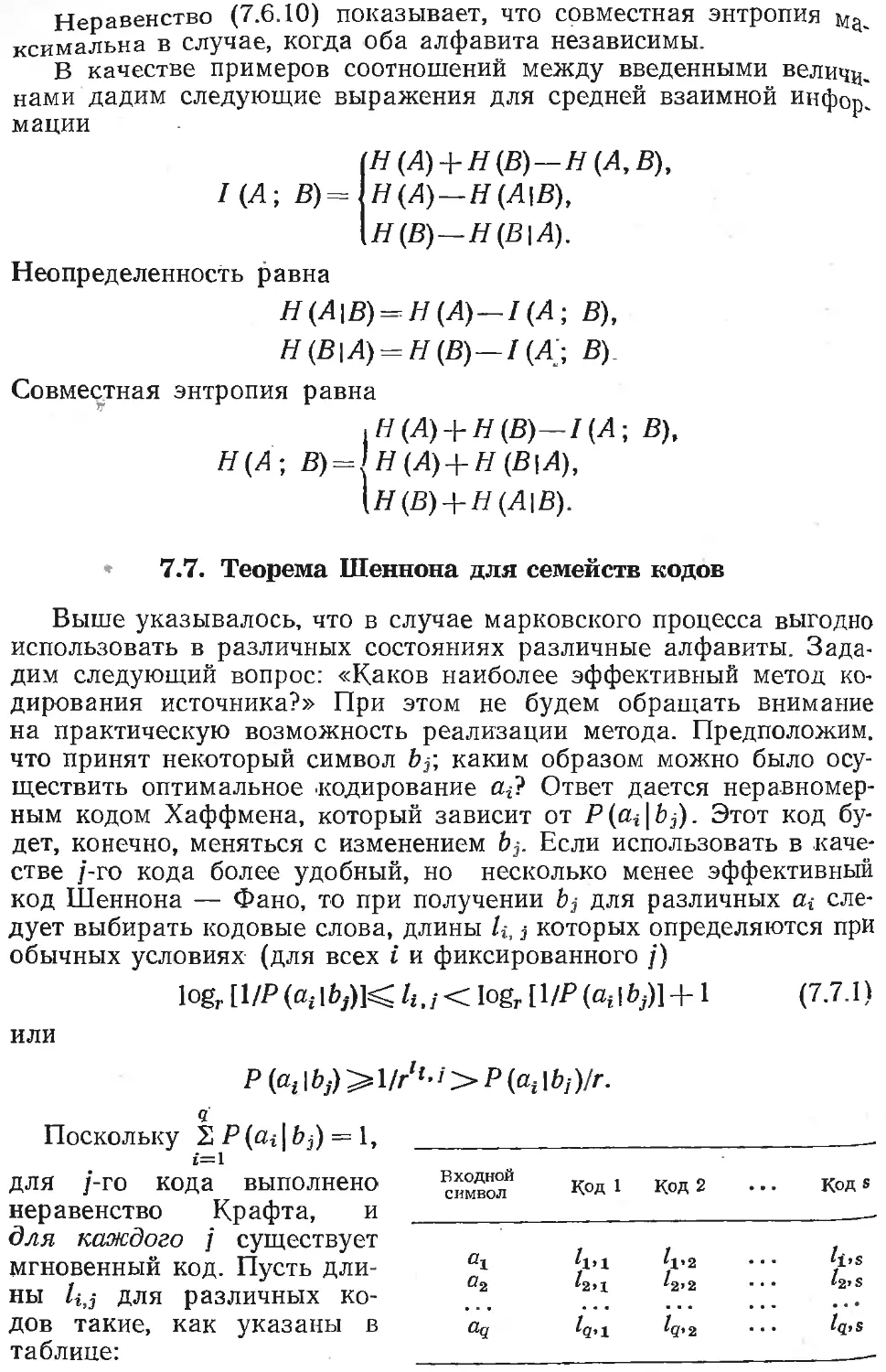

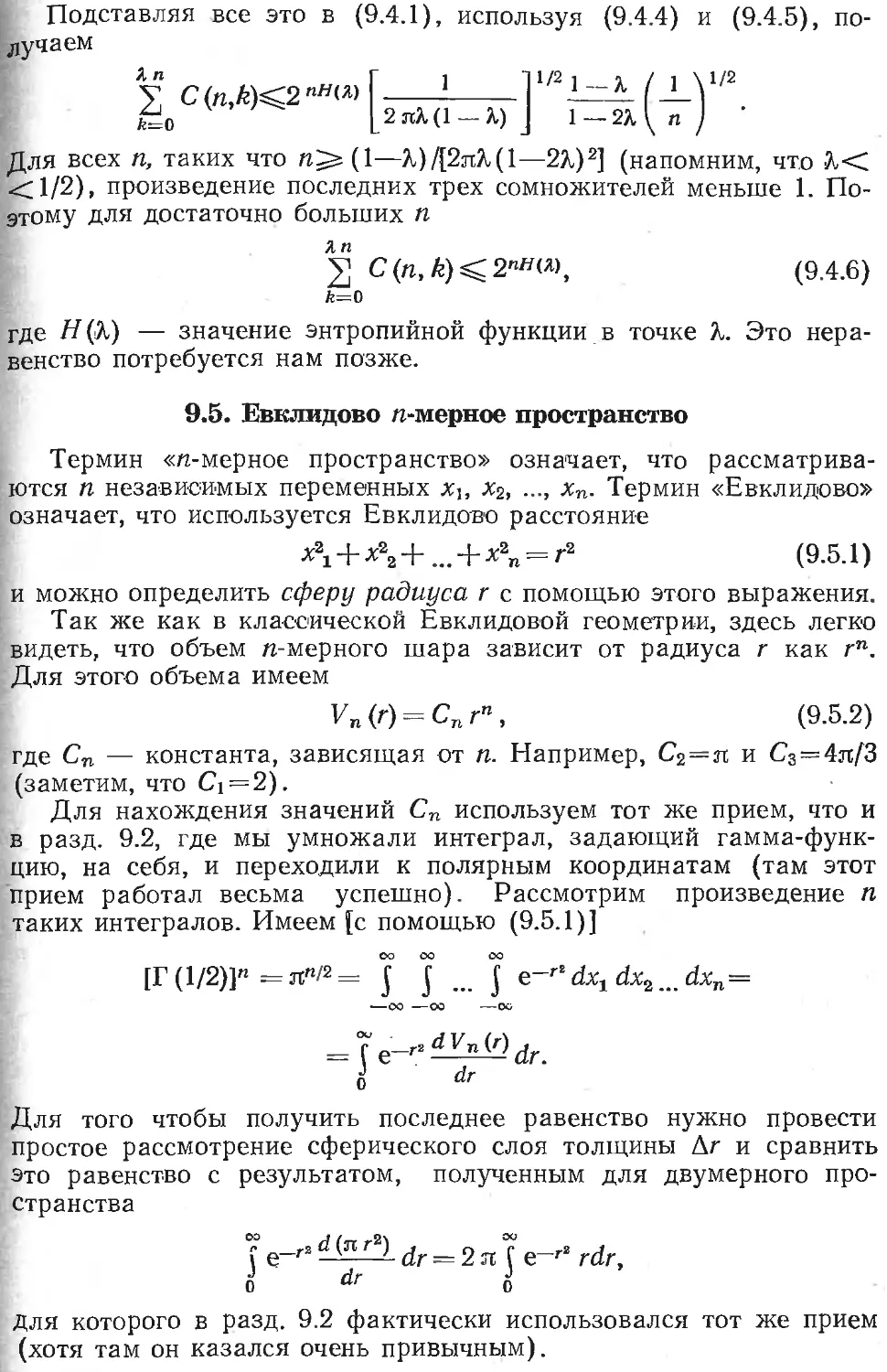

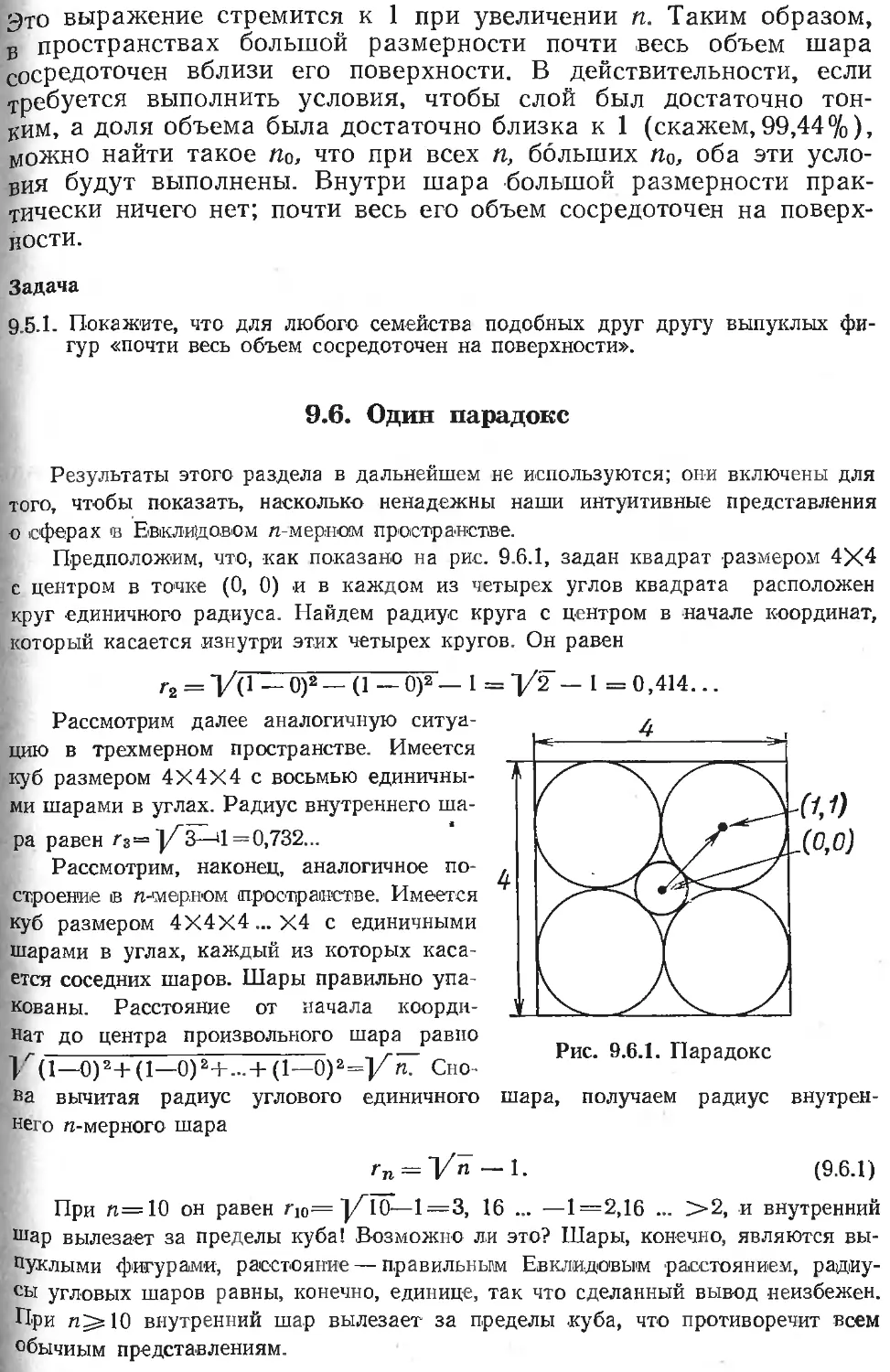

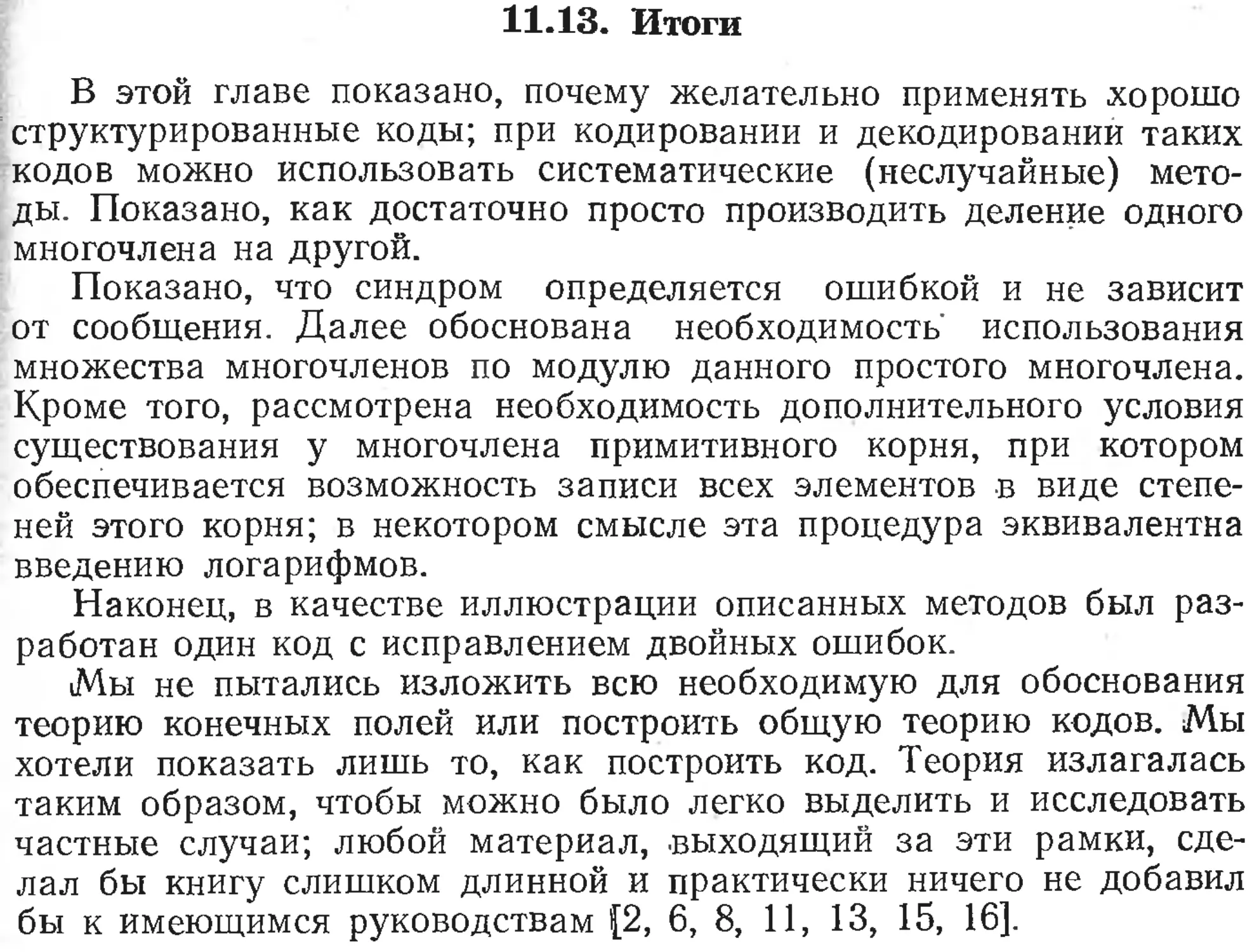

Рис. 1.3.1. Стандартная система передачи сигналов

ляющегося к сигналу в канале; 5) декодирование, и по возможно-

сти восстановление первоначальной информации по принятому

искаженному сигналу; 6) получатель информации.

Эта модель показана на рис. 1.3.1 и будет использоваться в

дальнейшем в качестве модели системы передачи сигналов. Мо-

дель отражает многие характерные черты применяемых в настоя-

щее время систем. Блок кодирования часто состоит из двух каска-

дов; в первом происходит кодирование для источника, а во вто-

D0M’__ дальнейшее кодирование для согласования с каналом. В

этом случае блок декодирования также состоит из двух каскадов.

Йачнем с концов системы и будем продвигаться к ее середине.

1.4. Источник сообщений

Рассмотрим источник сообщений. Теория кодирования и'тео-

рия информации во многом обязаны своей силой тому, что они

не определяют, что такое информация, а просто предполагают,

что задан источник сообщений как последовательность символов

Si, s2, ..., sq алфавита источника. В гл. 6 показано, что теория ин-

формации использует энтропию Н как меру информации, и ©то

позволяет определить, что значит количество информации. Одна-

ко такое определение является абстрактным, оно лишь частично

согласуется с общепринятыми представлениями об информации.

Возможно, именно представление о том, что здесь удалось форма-

лизовать и трактовать общие понятия информации, привело к та-

кой популярности теории информации на ее ранних этапах; раз-

личия в несходных ситуациях не были замечены, и считалось, что

теория применима во всех случаях. Данное определение приводит

к правильной мере информации во многих случаях (например,

при хранении и передаче данных) и поэтому люди стали думать,

что у них имеется одна из таких ситуаций, но они часто ошиба-

лись. Теория информации имеет дело не со смыслом информации,

а лишь с ее количеством.

Источник сообщений может быть самым различным: например,

книга, .печатное формальное уведомление и финансовый отчет

компании в равной мере являются источниками сообщений в обыч-

ном алфавите. Танец, музыка и другие формы человеческой дея-

тельности приводят к различным формам (символам) выражения

содержащейся в них информации и поэтому также могут считать-

ся источниками сообщений. Математические равенства — это еще

один источник сообщений. Рассматриваемые ниже коды являются

различными способами представления информационных символов

источника.

^Информация может существовать также в непрерывной форме;

Действительно, природа обычно приводит к информации именно в

такой форме. Однако на практике задача состоит в том, чтобы

брать отсчеты непрерывного сигнала через равные промежутки

®Рсмени и затем переводить их в цифровую форму (квантовать;

lyJ). Затем информация посылается как последовательность

цифр. Одна из причин использования цифровых отсчетов аналого-

вого сигнала заключается в том, что они могут передаваться на-

дежнее, чем аналоговый сигнал. Когда неизбежный шум в системе

передачи начинает искажать сигнал, цифровые импульсы могут

быть приняты (детектированы), .преобразованы и переведены в

стандартную форму до того, как их отправят далее к получателю.

В пункте назначения цифровые импульсы могут, при желании,

быть переведены снова в аналоговую форму. Аналоговые сигналы

не могут быть преобразованы в стандартную форму таким же спо-

собом, и поэтому чем дольше сигнал передается и чем больше он

обрабатывается, тем сильнее он искажается за счет малых оши-

бок.

Другая причина использования цифровых методов в современ-

ных системах состоит в том, что в настоящее время интегральные

схемы очень дешевы, и служат мощным аппаратом для гибкой и

надежной обработки и преобразования цифровых сигналов.

Хотя в теории информации есть раздел, посвященный анало-

говым сигналам, ограничимся цифровыми сигналами вследствие

большей простоты теории, а также потому, что, как отмечалось

выше, -значение аналоговых сигналов в технике постепенно умень-

шается. Почти все мощные большие ЭВМ являются цифровыми, и

в системах обработки информации они почти полностью замени-

ли прежние аналоговые машины. На 1979 г. осталось лишь не-

сколько больших гибридных систем общего назначения. Большин-

ство наших систем передачи информации, включая обычный теле-

фон, -быстро переводятся в цифровые.

1.5. Кодирование алфавита источника

Обычно информация (цифровые сигналы или попросту симво-

лы) представляется одним из двух возможных состояний; пере-

ключатель в верхнем или нижнем 'положении, включен или выклю-

чен, дырка на перфоленте выбита или нет, реле замкнуто или

разомкнуто, транзистор проводит или нет, магнитный домен име-

ет поле в одном или другом направлении и т. д. В настоящее вре-

мя устройства с двумя состояниями, названные двоичными, суще-

ственно надежнее устройств с несколькими состояниями. В резуль-

тате двоичные системы распространены гораздо шире, чем все

другие. Даже десятичные системы обработки информации, на-

пример, карманные калькуляторы, обычно конструируются на ос-

нове двоичных компонентов.

В качестве названий этих двух состояний принято использо-

вать символы 0 и 1, однако годятся любые два различных симво-

ла (знака), например, крестик и нолик. Иногда полезно рассмат-

ривать 0 и 1 не как числа, а как пару произвольных символов.

Рассмотрим сначала задачу представления различных симво-

лов алфавита источника. Если дана пара двоичных (с двумя со-

стояниями) устройств (цифр), их можно представить четырьмя

различными состояниями: 00, 01, 10, 11. Для трех двоичных цифр

получаем 23 = 8 различных состояний: ООО, 001, 010, 011, 100, 101,

НО, 111. Для системы, имеющей k двоичных цифр, обычно назы-

ваемых битами, общее число различных состояний равно 2к; это

легко получить, применив элементарные комбинаторные рассуж-

дения. Вообще, если есть k различных устройств, первое из кото-

рых имеет П1 состояний, второе — и2 состояний, Аое — nk со-

стояний, то общее число состояний, очевидно, равно произведению

П1П2 — nk- Если, например, ni=4, и2 = 2 и и3=5, то можно пред-

ставить 4X2X5=40 различных объектов (состояний). Это число

равно числу различных символов источника, которые можно пред-

ставить, если интересоваться только числом различных состояний.

В гл. 4 указывается, как принимать во внимание вероятности

появления различных символов. Сейчас рассматривается только

число различных состояний — это эквивалентно тому, что вероят-

ности появления всех символов считаются равными.

Выше рассматривались двоичные устройства с двумя символа-

ми; существуют, конечно, устройства с большим числом состоя-

ний, типа переключателя с нейтральным положением, имеющего

три состояния. Некоторые системы передачи сигналов также ис-

пользуют больше двух состояний, однако теория проще всего

строится в терминах двух состояний. Поэтому в книге обычно

речь идет о двоичной системе, а системы с г состояниями лишь

иногда упоминаются.

Люди часто приписывают последовательностям из нулей и

единиц некоторый смысл, например в коде ASCII (см. табл.

1.7.1). Однако ЭВМ (или система передачи сигналов) рассматри-

вает их лишь как последовательности из нулей и единиц. Цифро-

вая вычислительная машина обрабатывает двоичные последова-

тельности символов; смысл этим последовательностям придает

пользователь (или, быть может, устройства ввода и вывода).

ЭВМ просто комбинирует нули и единицы в соответствии со своей

конструкцией и введенной в нее программой. Логические схемы

ЭВМ не чувствительны к смыслу, который приписывается симво-

лам; это же справедливо для системы передачи сигналов.

Именно поэтому теория информации не рассматривает смысла

сообщений, и это дает ей возможность понять, как аппаратура

преобразует сообщения; теория дает метод исследования обра-

ботки информации.

В типичных случаях, как показано в гл. 2 и 3, кодирование

сообщений для передачи по каналу увеличивает избыточность

(точные определения даются в дальнейшем). Кодирование для ис-

точника (оно упоминалось в конце разд. 1.3) обычно уменьшает

избыточность, что показано в гл. 4 и 5.

Нужно представить себе источник как случайный или стоха-

стический и задаться вопросом, как можно закодировать, пере-

дать и восстановить переданную информацию. Переданы были,

конечно, некоторые конкретные сообщения, однако у проектиров-

щика системы нет никакого способа узнать, какие сообщения из

множества (ансамбля) возможных сообщений будут выбраны для

передачи. Проектировщик должен рассматривать посылаемое со-

общение как случайную выборку из множества всех возможных

сообщений и спроектировать систему таким образом, чтобы обес-

печить передачу всех возможных сообщений. Таким образом, по

существу, теория является вероятностной, однако в этой книге ис-

пользуются лишь элементы теории вероятностей.

Задачи

1.5.1. Найдите число различных автомобильных номеров вида «цифра, цифра,

цифра, буква, буква, буква».

1.5.2. Сколько команд может быть у ЭВМ, если каждая команда состоит из 8

двоичных символов.

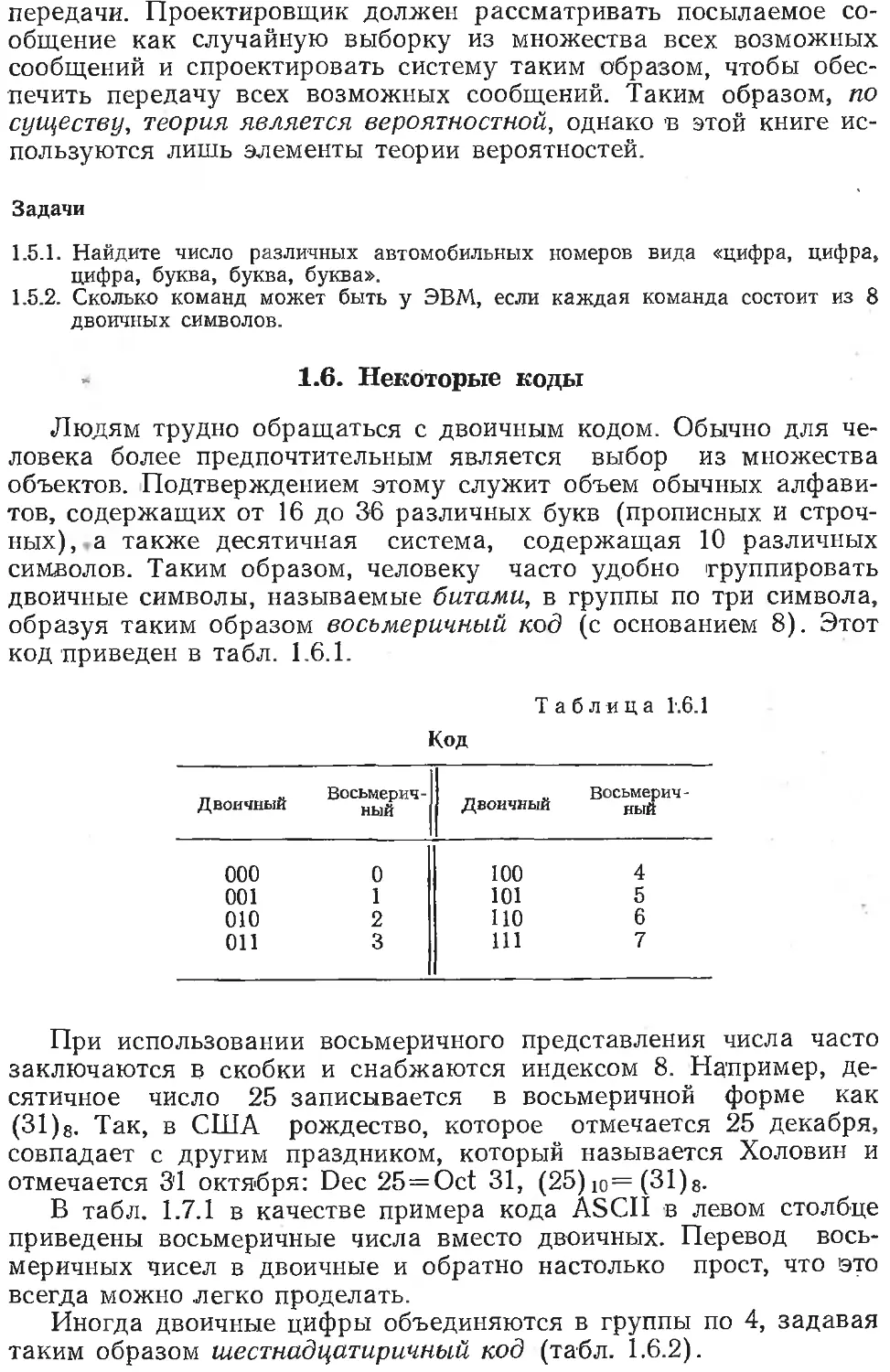

1.6. Некоторые коды

Людям трудно обращаться с двоичным кодом. Обычно для че-

ловека более предпочтительным является выбор из множества

объектов. Подтверждением этому служит объем обычных алфави-

тов, содержащих от 16 до 36 различных букв (прописных и строч-

ных), а также десятичная система, содержащая 10 различных

символов. Таким образом, человеку часто удобно группировать

двоичные символы, называемые битами, в группы по три символа,

образуя таким образом восьмеричный код (с основанием 8). Этот

код приведен в табл. 1.6.1.

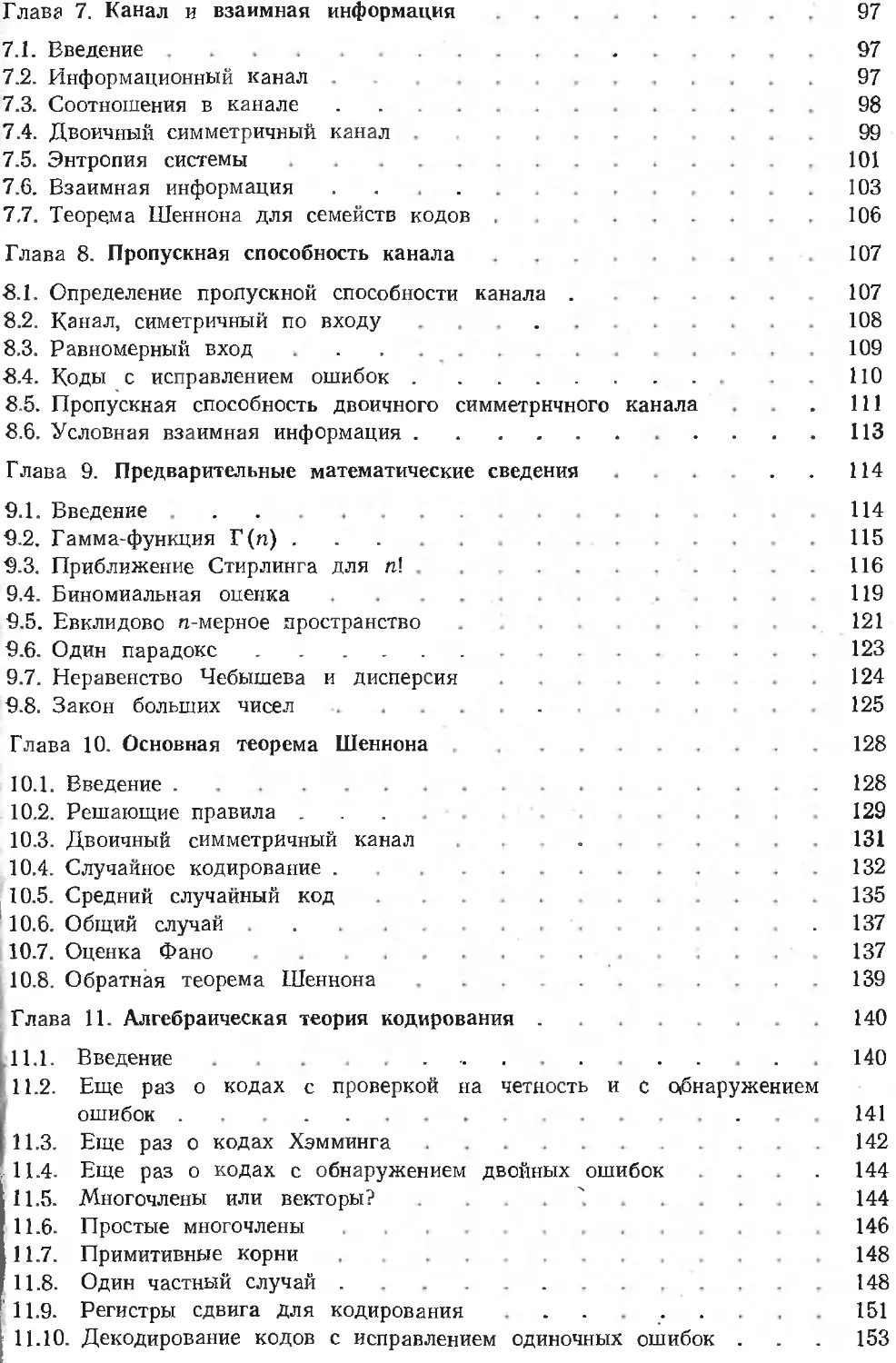

Таблица 1.6.1

Код

Двоичный Восьмерич- ный Двоичный Восьмерич- ный

ООО 0 100 4

001 1 101 5

010 2 110 6

011 3 111 7

При использовании восьмеричного представления числа часто

заключаются в скобки и снабжаются индексом 8. Например, де-

сятичное число 25 записывается в восьмеричной форме как

(31) 8. Так, в США рождество, которое отмечается 25 декабря,

совпадает с другим праздником, который называется Холовин и

отмечается 3'1 октября: Dec 25=Oct 31, (25)ю= (31)8.

В табл. 1.7.1 в качестве примера кода ASCII в левом столбце

приведены восьмеричные числа вместо двоичных. Перевод вось-

меричных чисел в двоичные и обратно настолько прост, что это

всегда можно легко проделать.

Иногда двоичные цифры объединяются в группы по 4, задавая

таким образом шестнадцатиричный код (табл. 1.6.2).

Поскольку ЭВМ обычно работают с байтами, каждый из кото-

рых состоит из 8 бит (в некоторых современных ЭВМ использу-

ются 9-битовые байты), шестнадцатиричный код лучше согласует-

ся с архитектурой ЭВМ; с другой стороны, восьмеричный код, по-

видимому, лучше согласуется с человеческой психологией. Поэто-

му на практике ни один код не может одержать уверенной по-

беды.

Код

Таблица 11.6.2

Двоичный Шестнад- цатирич- ный Двоичный Шестнад- цатирич- ный

0000 0 1000 8

0001 1 1001 9

0010 2 1010 А

ООП 3 1011 В

0100 4 1100 С

0101 5 1101 D

оно 6 1110 Е

0111 7 1111 F

1.6.1. Используя приближенное равенство 2S~3S, сравните вычислительные ма-

шины с двоичным и троичным основаниями.

1.6.2. Составьте восьмеричную таблицу умножения.

1.6.3. Используя таблицу 1.6.2, найдите двоичное представление для D6. Ответ:

110 10 110.

Задачи

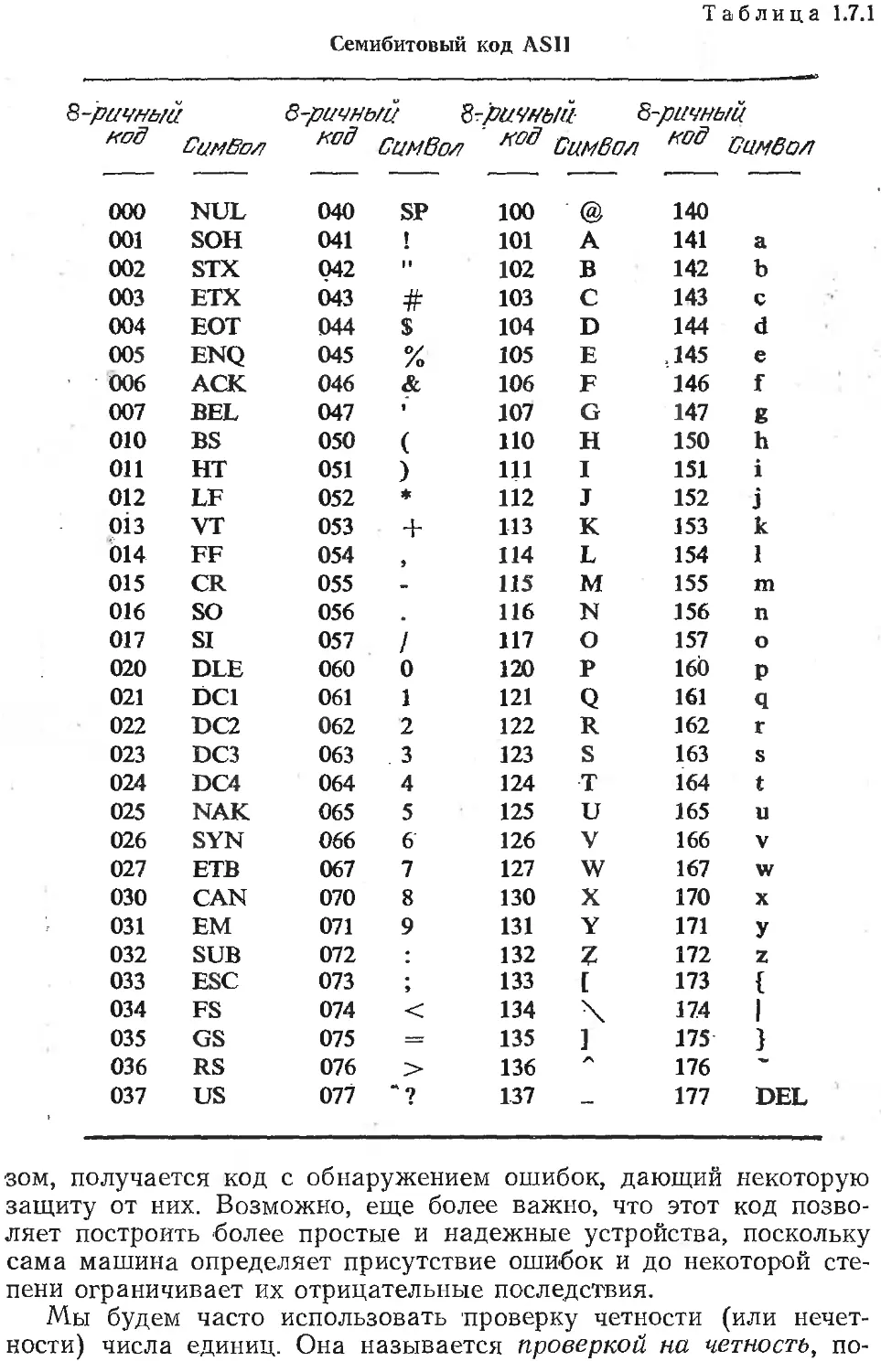

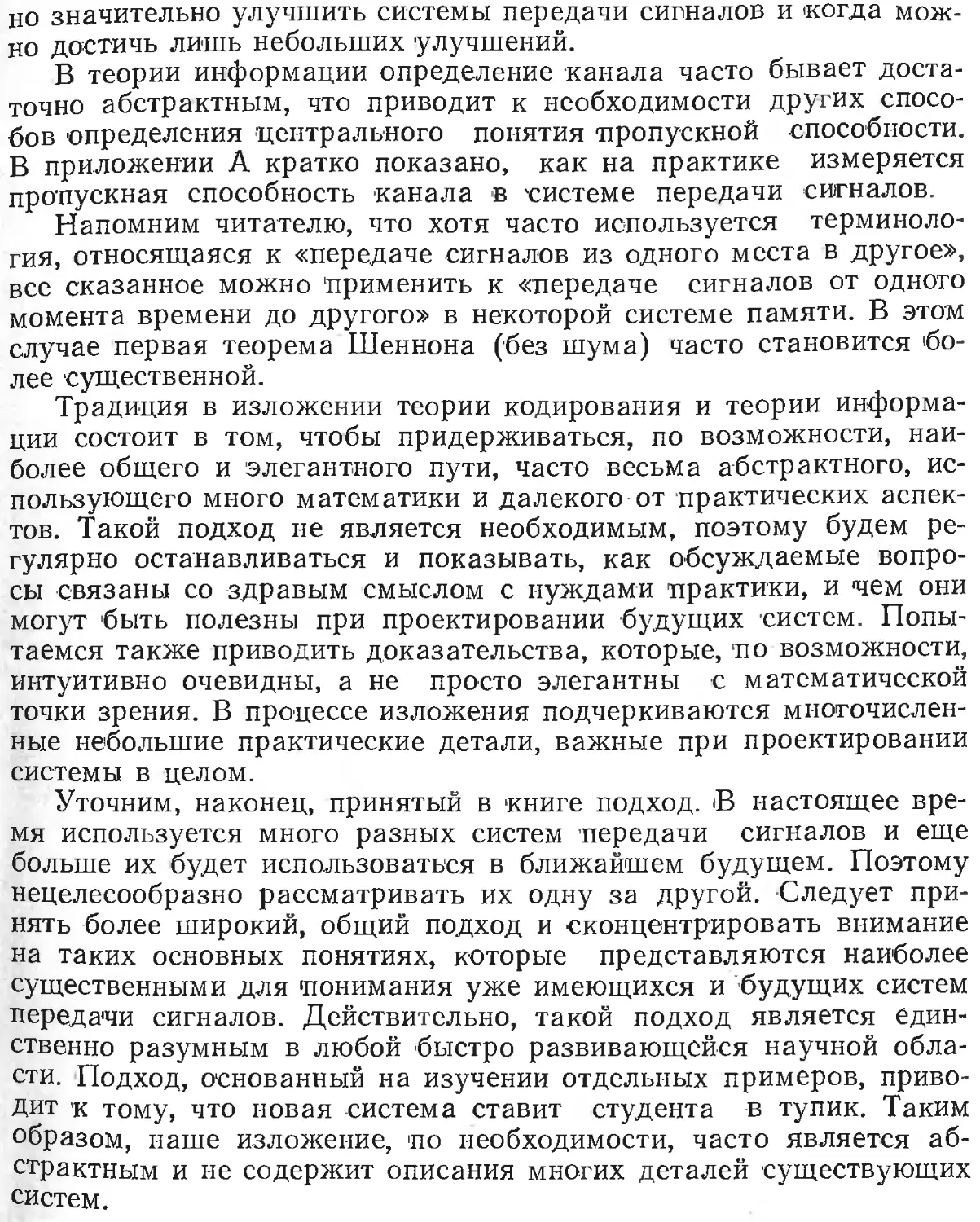

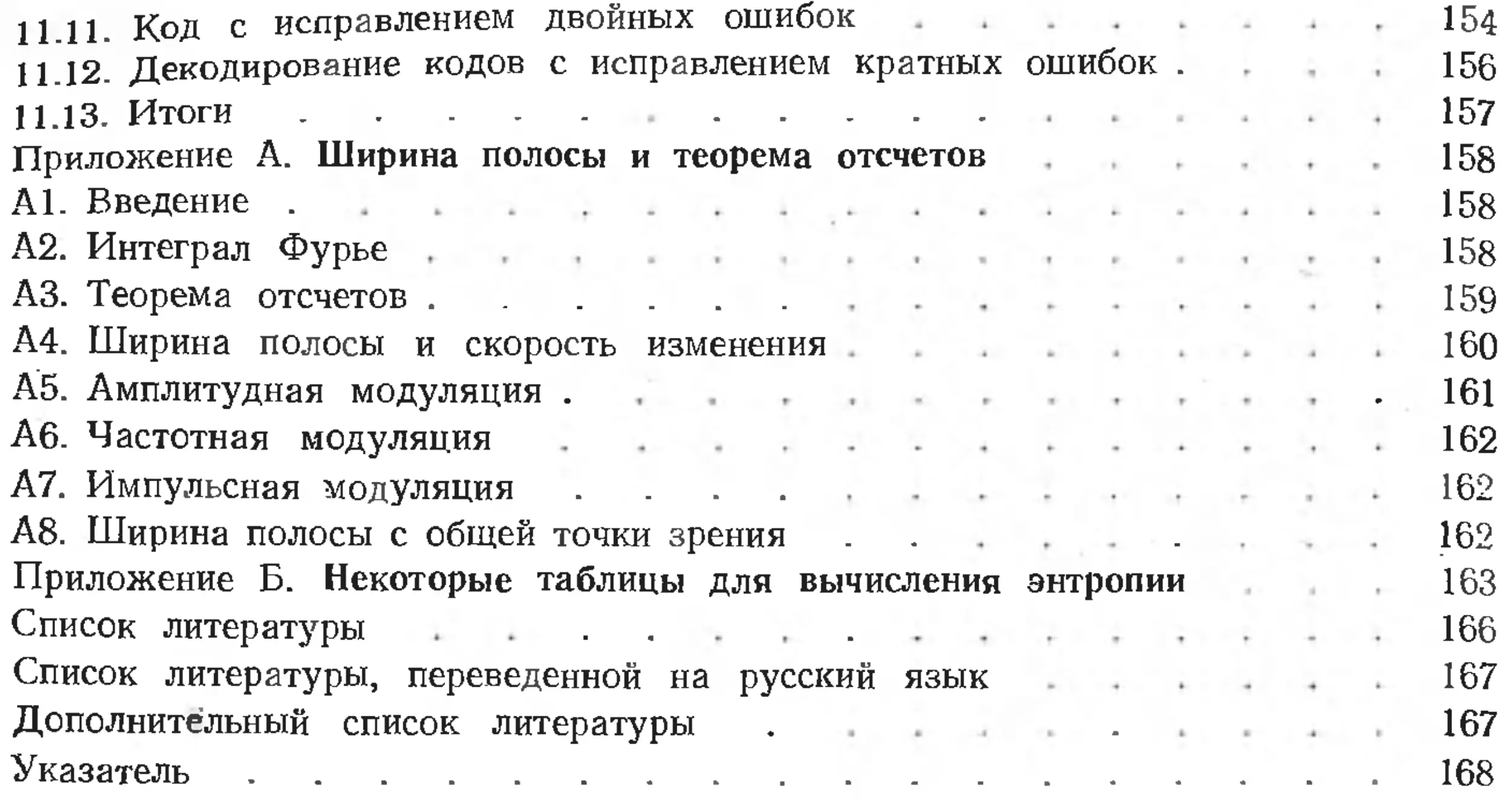

1.7. Код ASCII

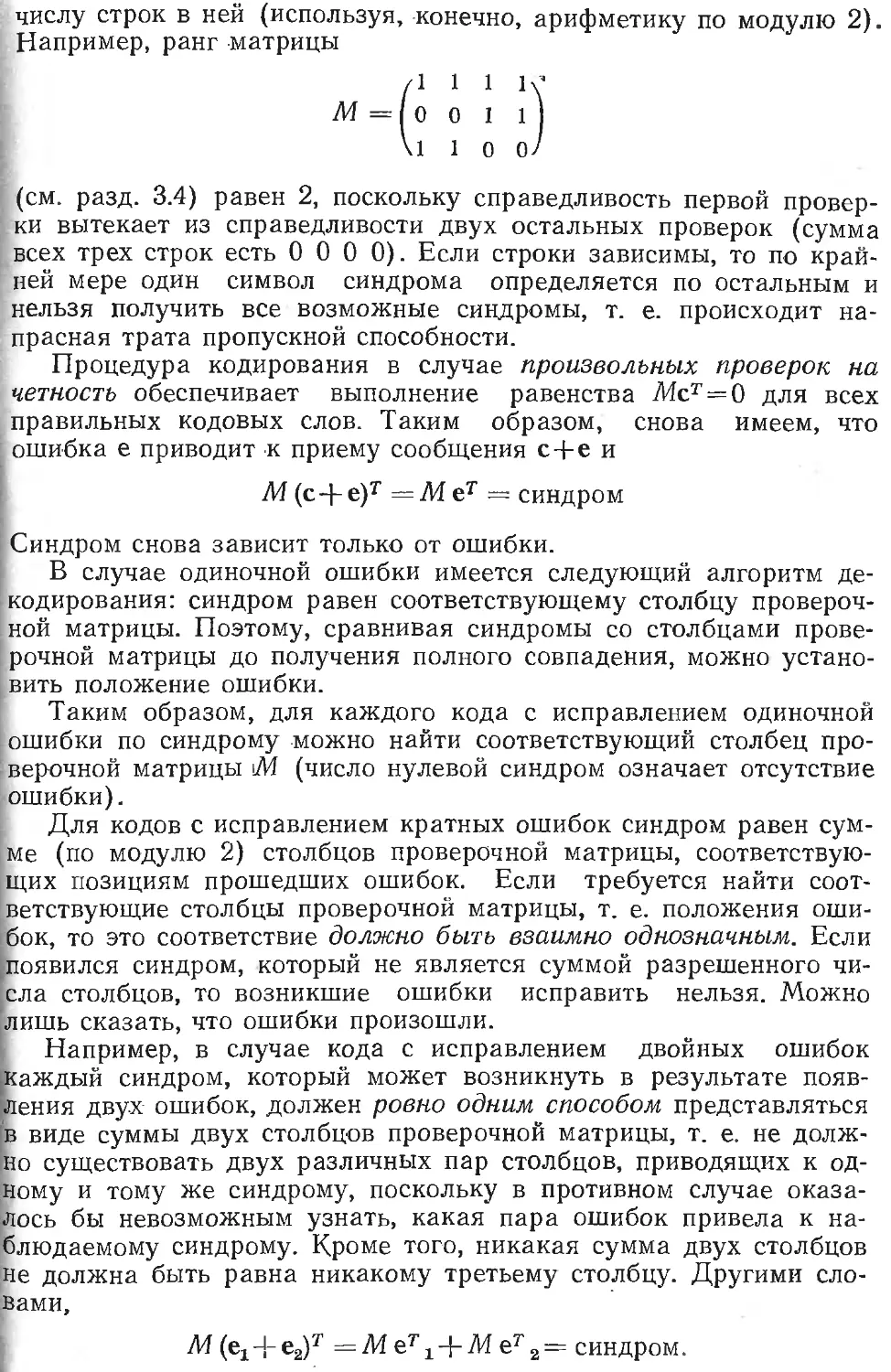

Пусть задан источник сообщений; рассмотрим сначала кодиро-

вание для этого источника. Стандартный код ASCII (табл. 1.7.1),

который представляет буквенные цифровые и некоторые другие

символы, является одним из примеров кода.

Этот код использует семь двоичных символов. Поскольку, как

уже отмечалось, ЭВМ работает с байтами, которые обычно явля-

ются блоками из 8 бит, один символ кода ASCII часто занимает

8 бит. Восьмой бит можно выбирать несколькими способами,

иногда равным 1, так что его можно использовать как тактовый

бит для синхронизации. Чаще ©тот бит выбирается так, чтобы об-

щее число единиц во всех восьми битах было четным (или нечет-

ным, см. пл. 2). Наконец, он может выбираться произвольно и ни-

как не использоваться. Для перевода в модифицированный код

ASCII, применяемый в 8-битовом телетайпном коде системы

LT 33, нужно взять 7-1битовый .код ASCII + (200) 8.

Цель, достигаемая установлением четного числа 1 в восьми

позициях, состоит в обнаружении любой одиночной ошибки, при

которой 0 заменяется на 1 или 1 на 0; при такой ошибке общее

число 1 во всех восьми позициях станет нечетным. Таким обра-

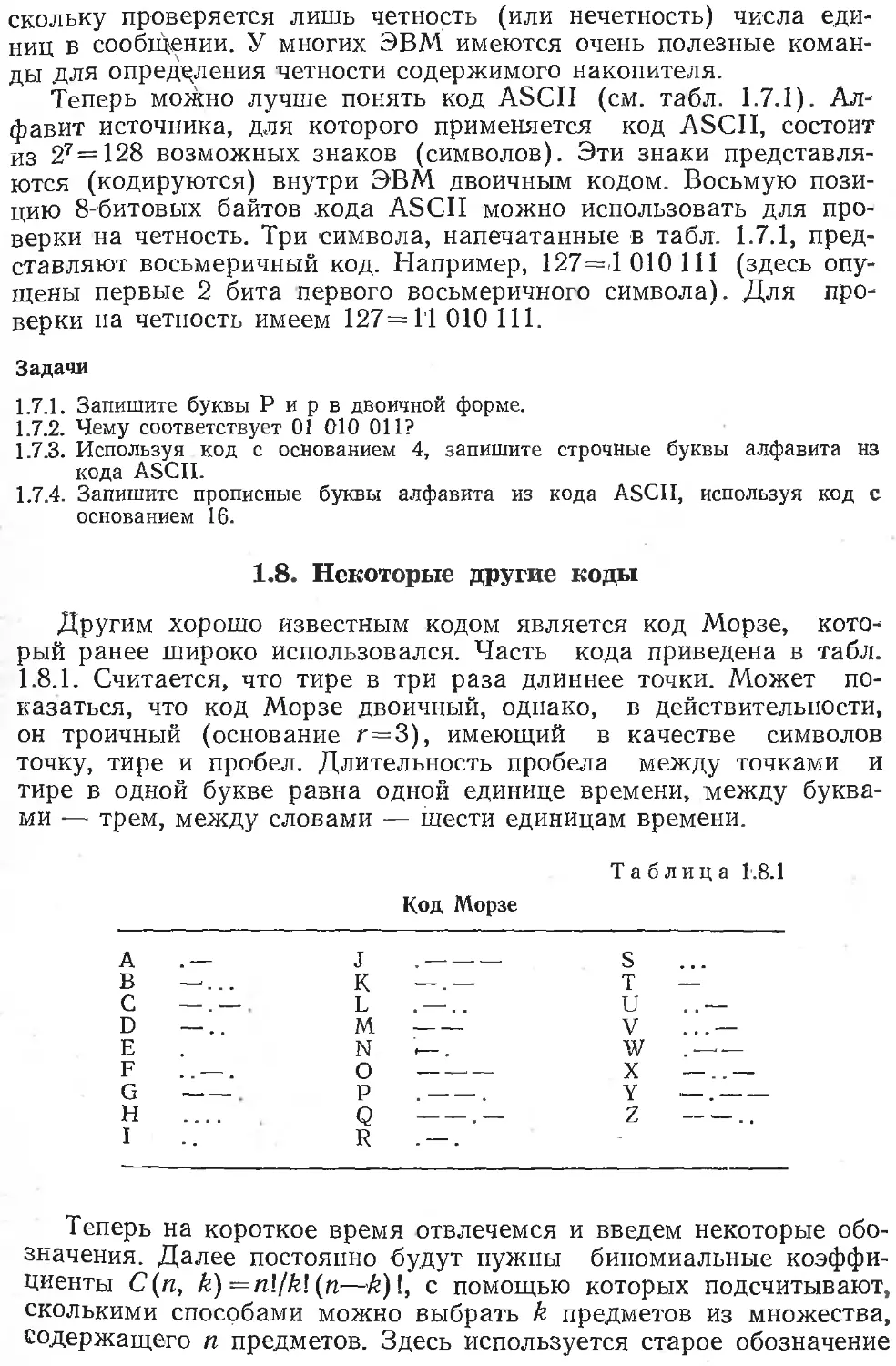

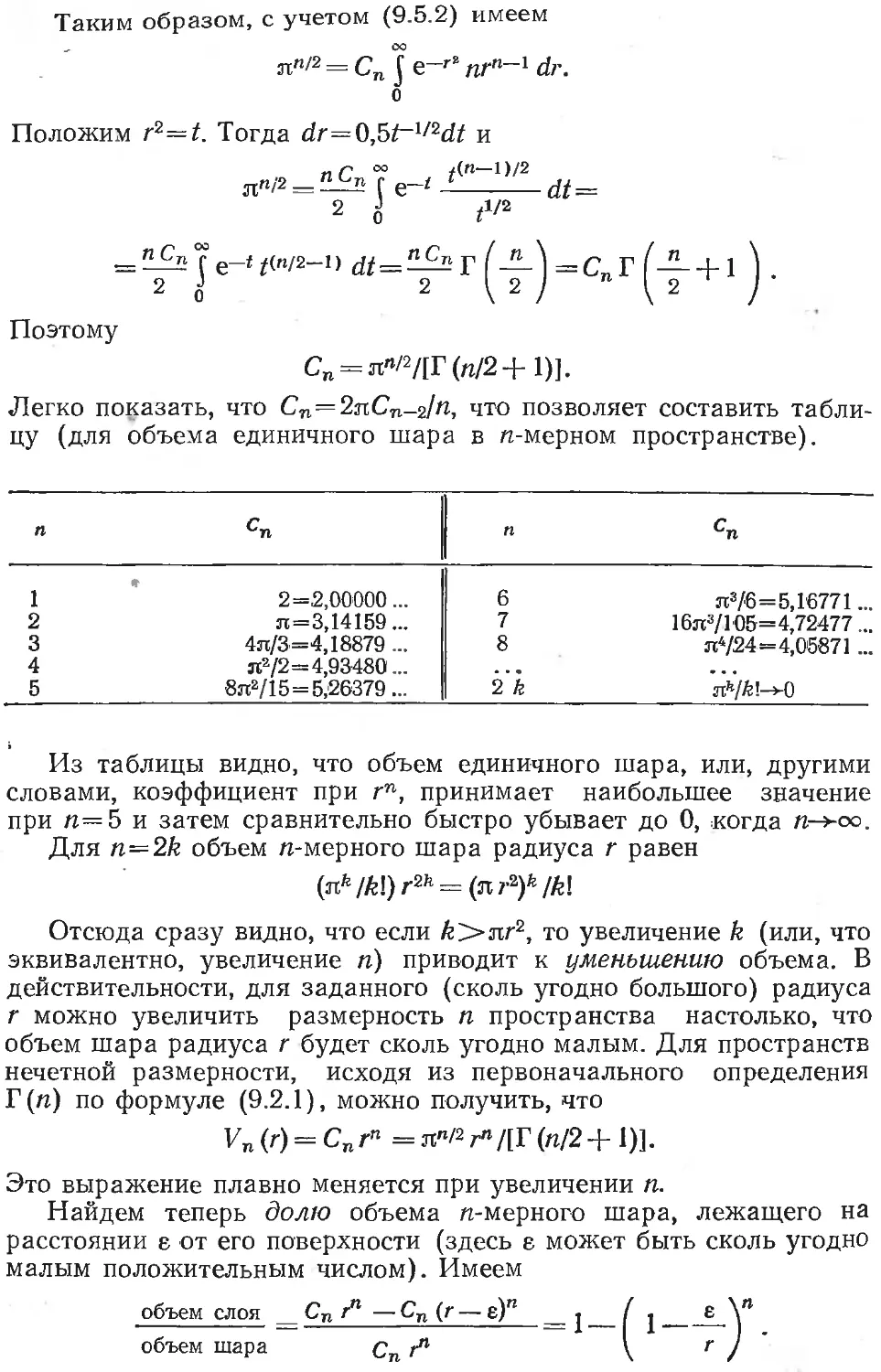

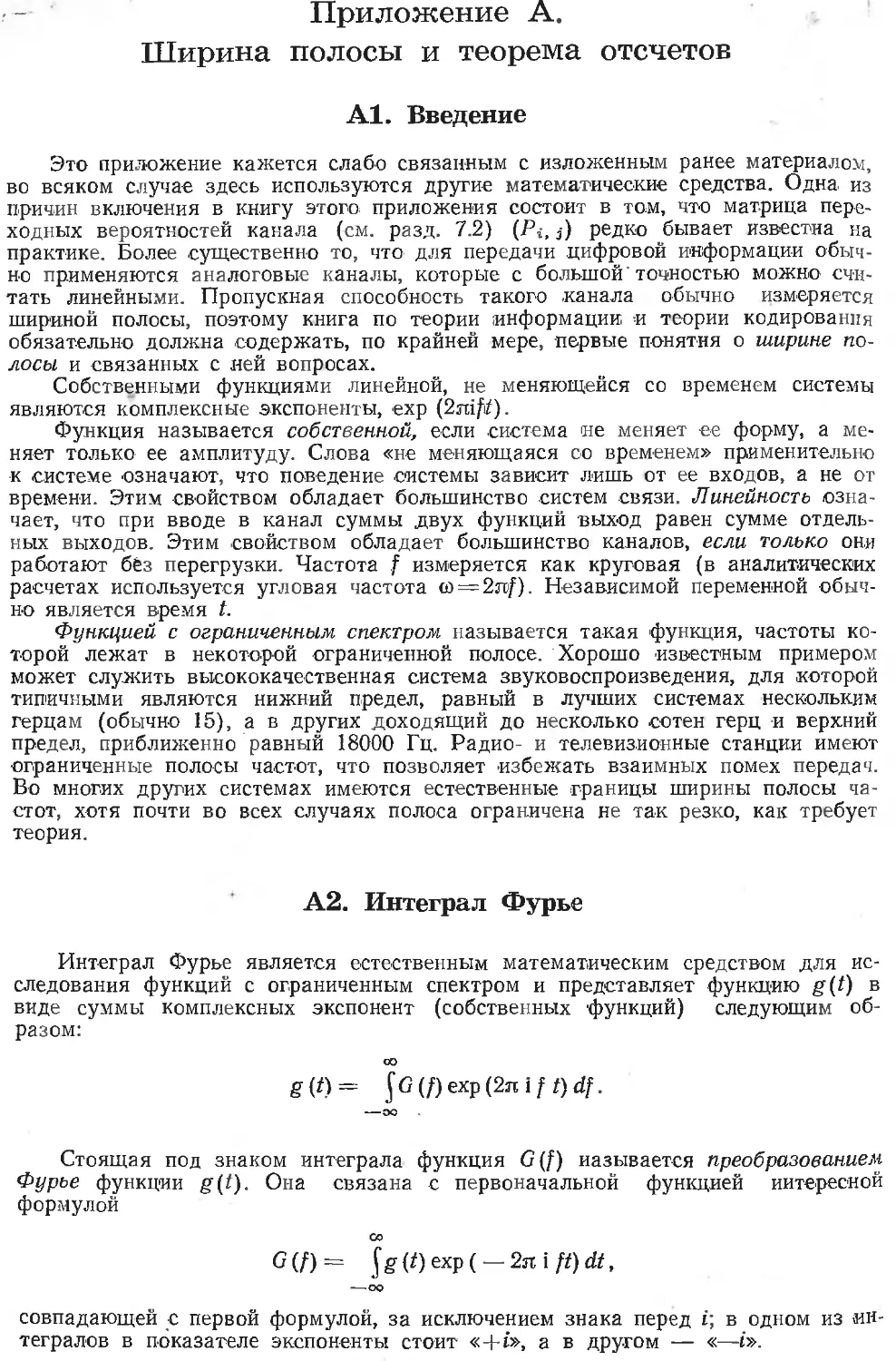

Семибитовый код AS II

Таблица 1.7.1

В-ришый иод в-ричный зримый 8-ричный /1 Символ

СомВо/г код CumBo/i , код CumBo.

ООО NUL 040 SP 100 140

001 SOH 041 I 101 A 141 a

002 STX 042 102 В 142 b

003 ЕТХ 043 # 103 c 143 c

004 EOT 044 $ 104 D 144 d

005 ENQ 045 О/ /о 105 E .145 e

006 АСК 046 & 106 F 146 f

007 BEL 047 107 G 147 g

010 BS 050 ( 110 H 150 h

011 НТ 051 ) 111 I 151 i

012 LF 052 * 112 J 152 j

013 УТ 053 + 113 К 153 k

014 FF 054 114 L 154 1

015 CR 055 - 115 M 155 m

016 SO 056 116 N 156 n

017 SI 057 / 117 О 157 о

020 DLE 060 0 120 P 160 p

021 DC1 061 1 121 Q 161 q

022 DC2 062 2 122 R 162 r

023 DC3 063 . 3 123 S 163 s

024 DC4 064 4 124 T 164 t

025 NAK 065 5 125 и 165 u

026 SYN 066 6 126 V 166 V

027 ETB 067 7 127 w 167 w

030 CAN 070 8 130 X 170 X

031 EM 071 9 131 Y 171 У

032 SUB 072 • 132 1 172 z

033 ESC 073 J 133 [ 173 {

034 FS 074 < 134 \ 174 1

035 GS 075 __ 135 ] 175 }

036 RS 076 136 176

037 US 077 * ? 137 — 177 DEL

зом, получается код с обнаружением ошибок, дающий некоторую

защиту от них. Возможно, еще более важно, что этот код позво-

ляет построить более простые и надежные устройства, поскольку

сама машина определяет присутствие ошибок и до некоторой сте-

пени ограничивает их отрицательные последствия.

Мы будем часто использовать проверку четности (или нечет-

ности) числа единиц. Она называется проверкой на четность, по-

скольку проверяется лишь четность (или нечетность) числа еди-

ниц в сообщении. У многих ЭВМ имеются очень полезные коман-

ды для определения четности содержимого накопителя.

Теперь можно лучше понять код ASCII (см. табл. 1.7.1). Ал-

фавит источника, д.пя которого применяется код ASCII, состоит

из 27 = 128 возможных знаков (символов). Эти знаки представля-

ются (кодируются) внутри ЭВМ двоичным кодом. Восьмую пози-

цию 8-битовых байтов кода ASCII можно использовать для про-

верки на четность. Три символа, напечатанные в табл. 1.7.1, пред-

ставляют восьмеричный код. Например, 127=4 010 111 (здесь опу-

щены первые 2 бита первого восьмеричного символа). Для про-

верки на четность имеем 127=1'1 010 111.

Задачи

1.7.1. Запишите буквы Р и р в двоичной форме.

1.7.2. Чему соответствует 01 010 011?

1.7.3. Используя код с основанием 4, запишите строчные буквы алфавита нз

кода ASCII.

1.7.4. Запишите прописные буквы алфавита из кода ASCII, используя код с

основанием 16.

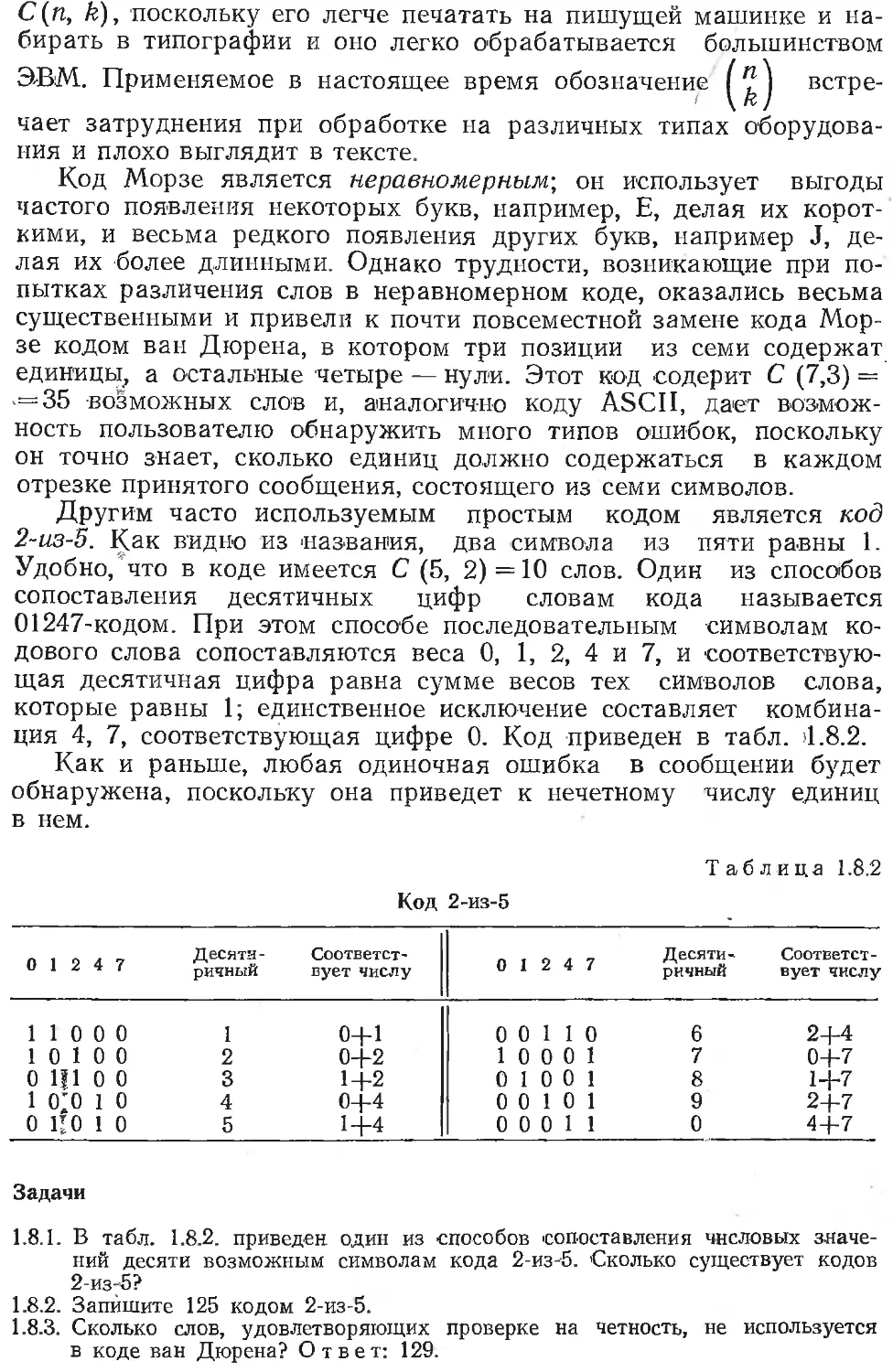

1.8. Некоторые другие коды

Другим хорошо известным кодом является код Морзе, кото-

рый ранее широко использовался. Часть кода приведена в табл.

1.8.1. Считается, что тире в три раза длиннее точки. Может по-

казаться, что код Морзе двоичный, однако, в действительности,

он троичный (основание г=3), имеющий в качестве символов

точку, тире и пробел. Длительность пробела между точками и

тире в одной букве равна одной единице времени, между буква-

ми — трем, между словами — шести единицам времени.

Таблица 1.8.1

Код Морзе

Теперь на короткое время отвлечемся и введем некоторые обо-

значения. Далее постоянно будут нужны биномиальные коэффи-

циенты С(п, k) —nl/kl(n—k)l, с помощью которых подсчитывают,

сколькими способами можно выбрать k предметов из множества,

Содержащего п предметов. Здесь используется старое обозначение

C(n, k), 'поскольку его легче печатать на пишущей машинке и на-

бирать в типографии и оно легко обрабатывается большинством

ЭВМ. Применяемое в настоящее время обозначение I ”

встре-

чает затруднения при обработке на различных типах оборудова-

ния и плохо выглядит в тексте.

Код Морзе является неравномерным-, он использует выгоды

частого появления некоторых букв, например, Е, делая их корот-

кими, и весьма редкого появления других букв, например J, де-

лая их более длинными. Однако трудности, возникающие при по-

пытках различения слов в неравномерном коде, оказались весьма

существенными и привели к почти повсеместной замене кода Мор-

зе кодом ван Дюрена, в котором три позиции из семи содержат

единицы, а остальные четыре — нули. Этот код содерит С (7,3) =

-=35 возможных слов и, аналогично коду ASCII, дает возмож-

ность пользователю обнаружить много типов ошибок, поскольку

он точно знает, сколько единиц должно содержаться в каждом

отрезке принятого сообщения, состоящего из семи символов.

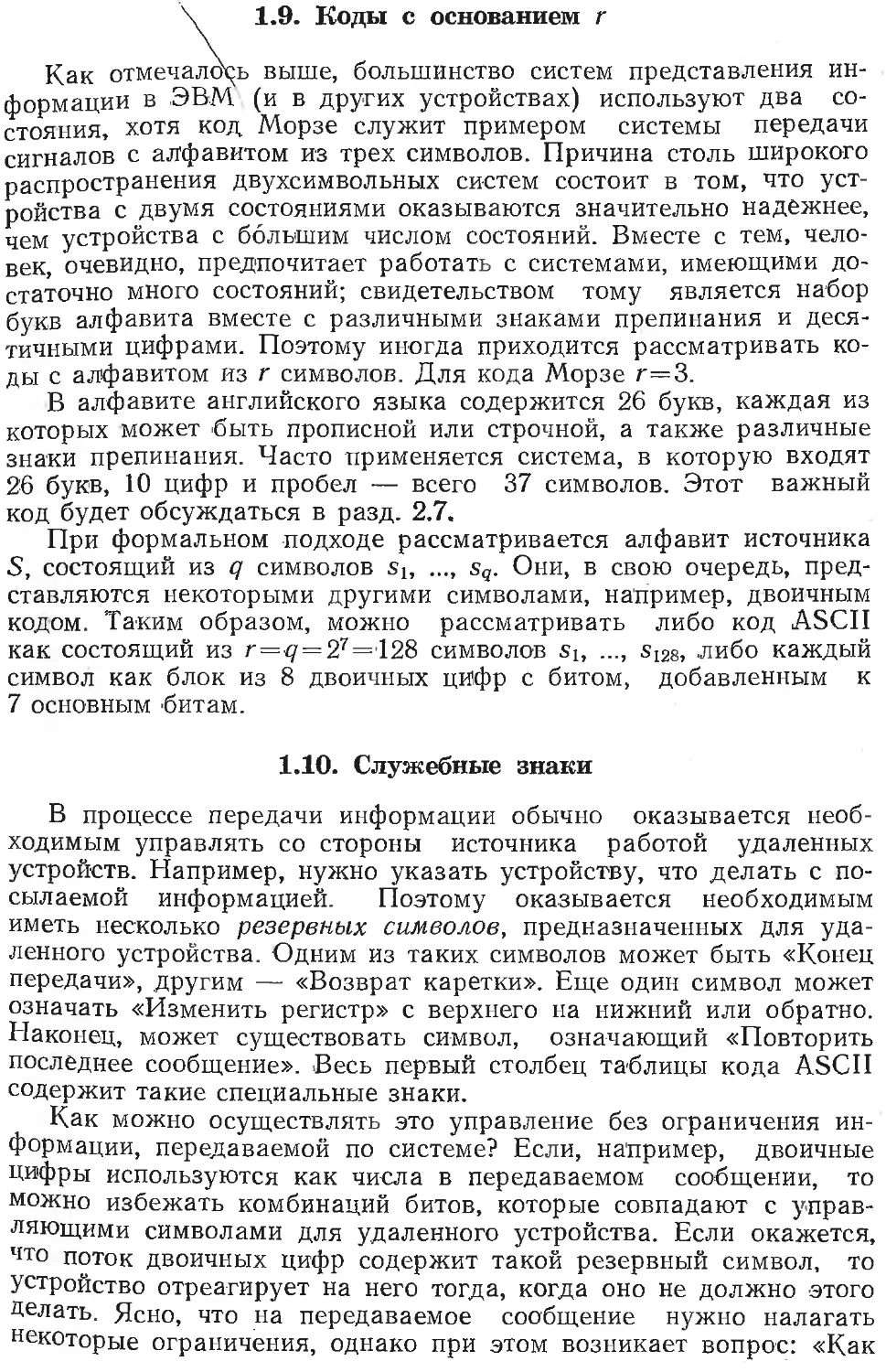

Другим часто используемым простым кодом является код

2-U3-5. Как видно из названия, два символа из пяти равны 1.

Удобно/что в коде имеется С (5, 2) = 10 слов. Один из способов

сопоставления десятичных цифр словам кода называется

01247-кодом. При этом способе последовательным символам ко-

дового слова сопоставляются веса 0, 1, 2, 4 и 7, и соответствую-

щая десятичная цифра равна сумме весов тех символов слова,

которые равны 1; единственное исключение составляет комбина-

ция 4, 7, соответствующая цифре 0. Код приведен в табл. >1.8.2.

Как и раньше, любая одиночная ошибка в сообщении будет

обнаружена, поскольку она приведет к нечетному числу единиц

в нем.

Таблица 1.8.2

Код 2-из-5

Десяти- Соответст- « , Л » Десяти- Соответст-

ричный вует числу ричный вует числу

110 0 0 1 2 0-|-1 0+2 0 0 1 0 1 1 0 6 7 2+4 0+7

1 0 1 0 0 0 0 1

0 Ц1 0 0 3 1+2 0 1 0 0 1 8 1+7

1 о;о 1 0 4 0+4 0 0 1 0 1 9 2+7

0 ЦО 1 0 5 1+4 0 0 0 1 1 0 4+7

Задачи

1.8.1. В табл. 1.8.2. приведен один из способов сопоставления числовых значе-

ний десяти возможным символам кода 2-из-5. Сколько существует кодов

2-из-5?

1.8.2. Запишите 125 кодом 2-из-5.

1.8.3. Сколько слов, удовлетворяющих проверке на четность, не используется

в коде ван Дюрена? Ответ: 129.

\ 1.9. Коды с основанием г

Как отмечалось выше, большинство систем представления ин-

формации в ЭВМ (и в других устройствах) используют два со-

стояния, хотя код Морзе служит примером системы передачи

сигналов с алфавитом из трех символов. Причина столь широкого

распространения двухсимвольных систем состоит в том, что уст-

ройства с двумя состояниями оказываются значительно надежнее,

чем устройства с большим числом состояний. Вместе с тем, чело-

век, очевидно, предпочитает работать с системами, имеющими до-

статочно много состояний; свидетельством тому является набор

букв алфавита вместе с различными знаками препинания и деся-

тичными цифрами. Поэтому иногда приходится рассматривать ко-

ды с алфавитом из г символов. Для кода Морзе г=3.

В алфавите английского языка содержится 26 букв, каждая из

которых может быть прописной или строчной, а также различные

знаки препинания. Часто применяется система, в которую входят

2'6 букв, 10 цифр и пробел — всего 37 символов. Этот важный

код будет обсуждаться в разд. 2.7.

При формальном подходе рассматривается алфавит источника

S, состоящий из q символов sb ..., sg. Они, в свою очередь, пред-

ставляются некоторыми другими символами, например, двоичным

кодом. Таким образом, можно рассматривать либо код ASCII

как состоящий из r=q=27 =128 символов sb ..., s12s, либо каждый

символ как блок из 8 двоичных цифр с битом, добавленным к

7 основным 'битам.

1.10. Служебные знаки

В процессе передачи информации обычно оказывается необ-

ходимым управлять со стороны источника работой удаленных

устройств. Например, нужно указать устройству, что делать с по-

сылаемой информацией. Поэтому оказывается необходимым

иметь несколько резервных символов, предназначенных для уда-

ленного устройства. Одним из таких символов может быть «Конец

передачи», другим — «Возврат каретки». Еще один символ может

означать «Изменить регистр» с верхнего на нижний или обратно.

Наконец, может существовать символ, означающий «Повторить

последнее сообщение». Весь первый столбец таблицы кода ASCII

содержит такие специальные знаки.

Как можно осуществлять это управление без ограничения ин-

формации, передаваемой по системе? Если, например, двоичные

Цифры используются как числа в передаваемом сообщении, то

можно избежать комбинаций битов, которые совпадают с управ-

ляющими символами для удаленного устройства. Если окажется,

что поток двоичных цифр содержит такой резервный символ, то

устройство отреагирует на него тогда, когда оно не должно этого

Делать. Ясно, что на передаваемое сообщение нужно налагать

некоторые ограничения, однако при этом возникает вопрос: «Как

это сделать наиболее безболезненно для пользователя системы.»

Один из возможных способов состоит в добавлении к каждому

блоку двоичных цифр еще одной цифры, например.О, если блок

представляет сообщение, и 1, если блок представляет управляю-

щую команду. Можно заметить, что если управляющие слова

встречаются редко, то применение этого способа приводит к су-

щественным потерям пропускной способности канала. Кроме то-

го, он не позволяет решить задачу ретрансляции управляющих

слов через одни устройства к другим.

Имеются другие способы решения задач передачи сообщения

через оконечное устройство, чтобы последнее на него не реагиро-

вало. Один часто используемый способ состоит в том, чтобы за-

ключить любой резервный символ в кавычки и организовать ра?

боту оконечного устройства так, чтобы оно не реагировало на то,

что заключено в кавычки, а лишь снимало их. Для того чтобы со-

хранить кавычки при прохождении по системе, их, в свою оче-

редь, следует также заключить в кавычки. Такой подход часто ис-

пользуется в ЭВМ, однако иногда он приводит к некоторой пута-

нице. Этот метод расстановки кавычек применяется, например, в

языке ФОРТРАН.

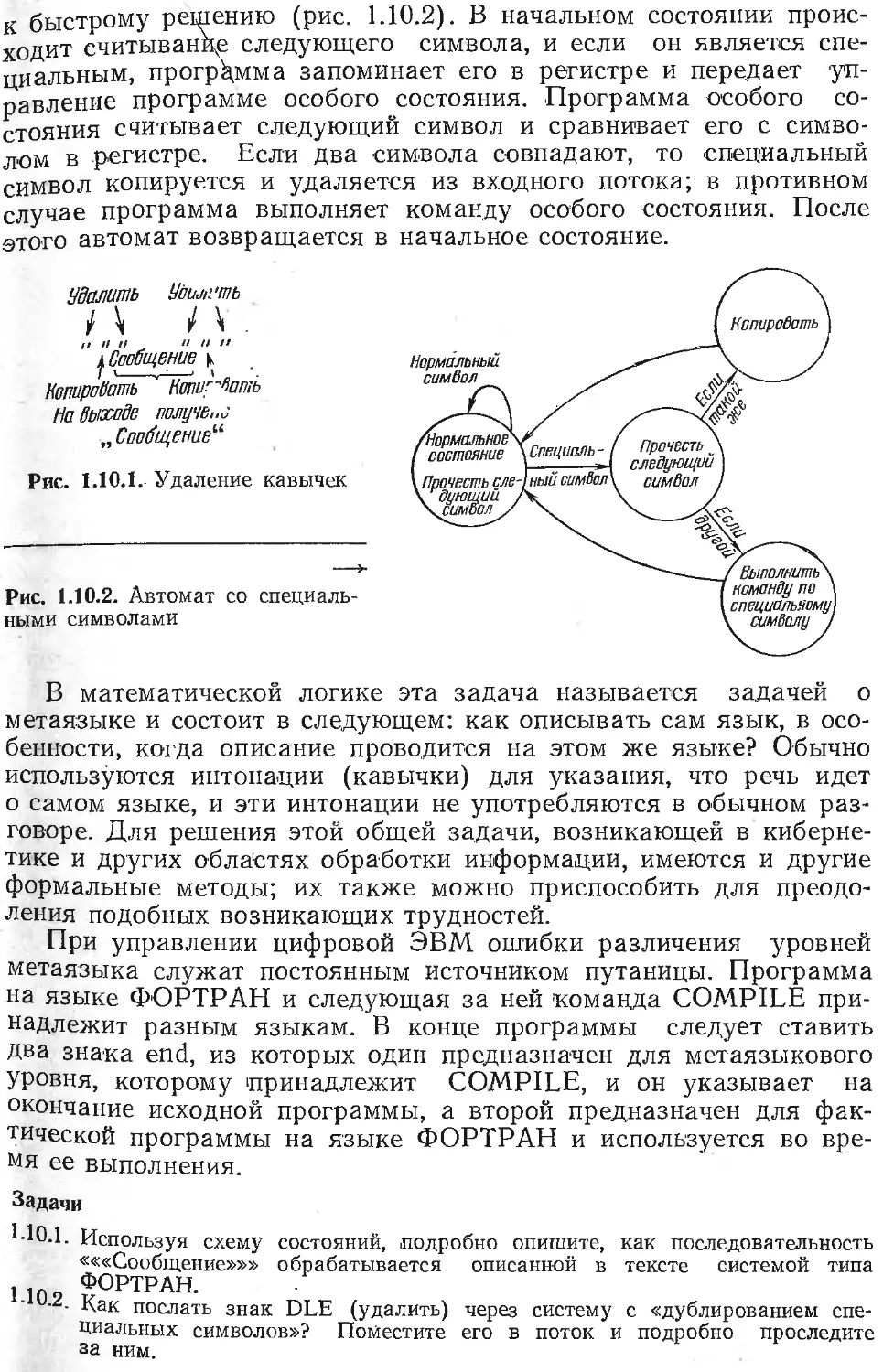

В языке ФОРТРАН появление кавычек приводит к тому, что

они удаляются из потока символов, и происходит копирование

следующего символа, независимо от того, является он кавычками

или нет. Если следующий символ не является кавычками, текст

копируется до очередного появления кавычек, которые удаляются,

после чего система выходит из состояния «Копировать следующий

символ». Если следующий символ — это кавычки, машина (про-

грамма), скопировав его, возвращается в нормальное состояние.

Таким образом, для получения одного символа кавычек нужно

повторить его дважды. Для того чтобы передать по системе сооб-

щения вида «Сообщение», следует написать «««Сообщение»»».

«Сообщение» может содержать любые резервные символы, отлич-

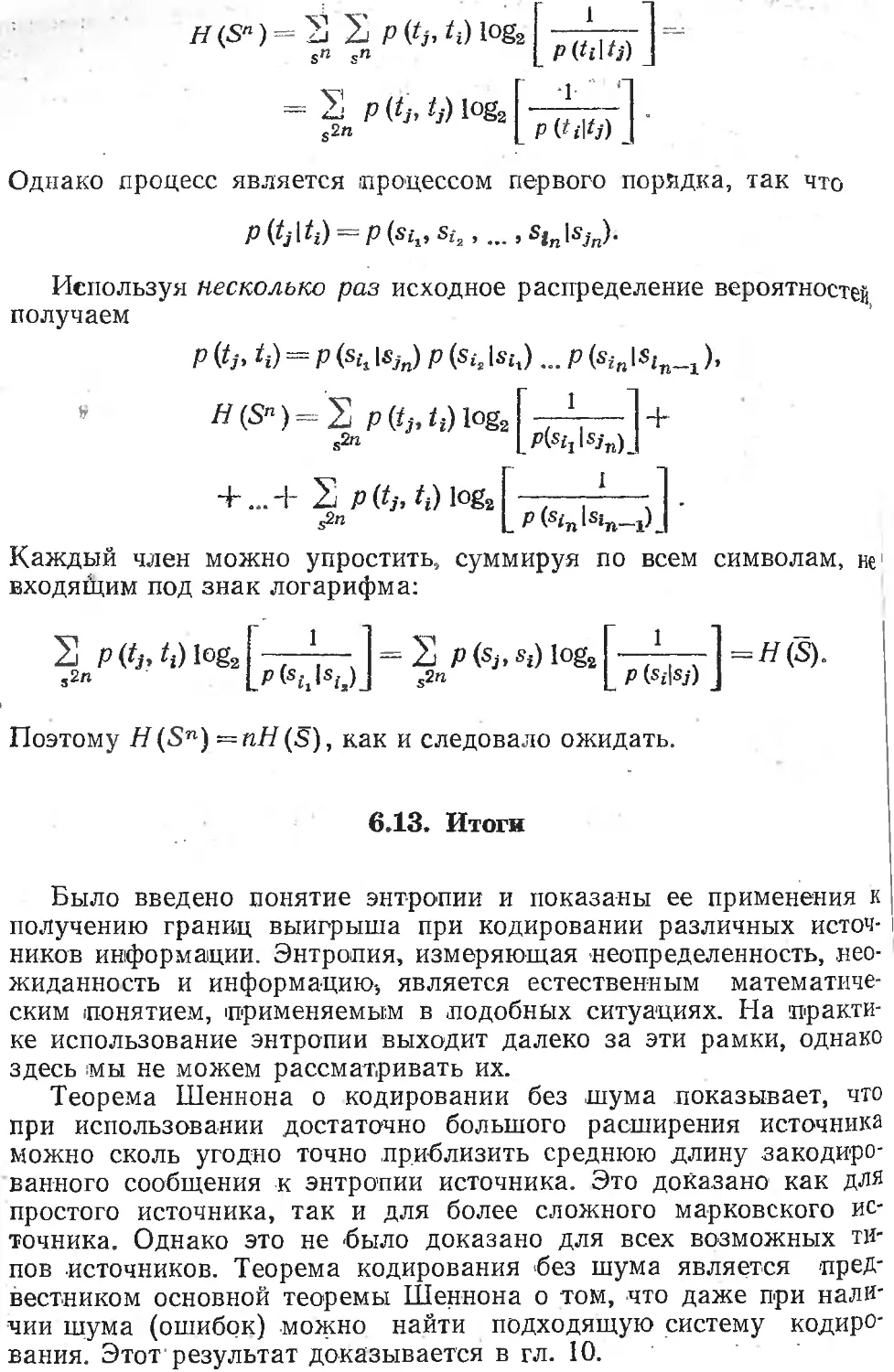

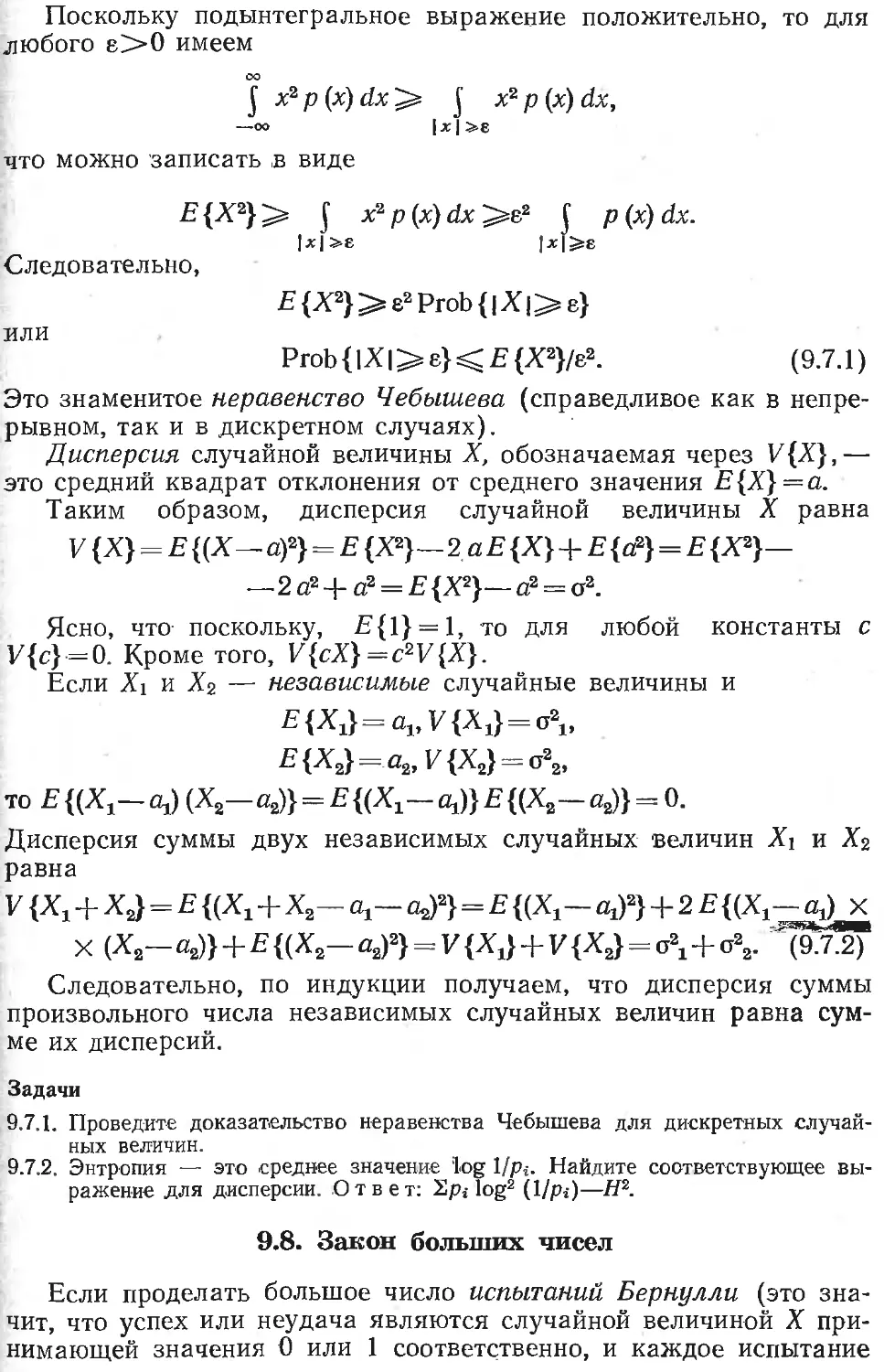

ные от (») (рис. 1.10.1).

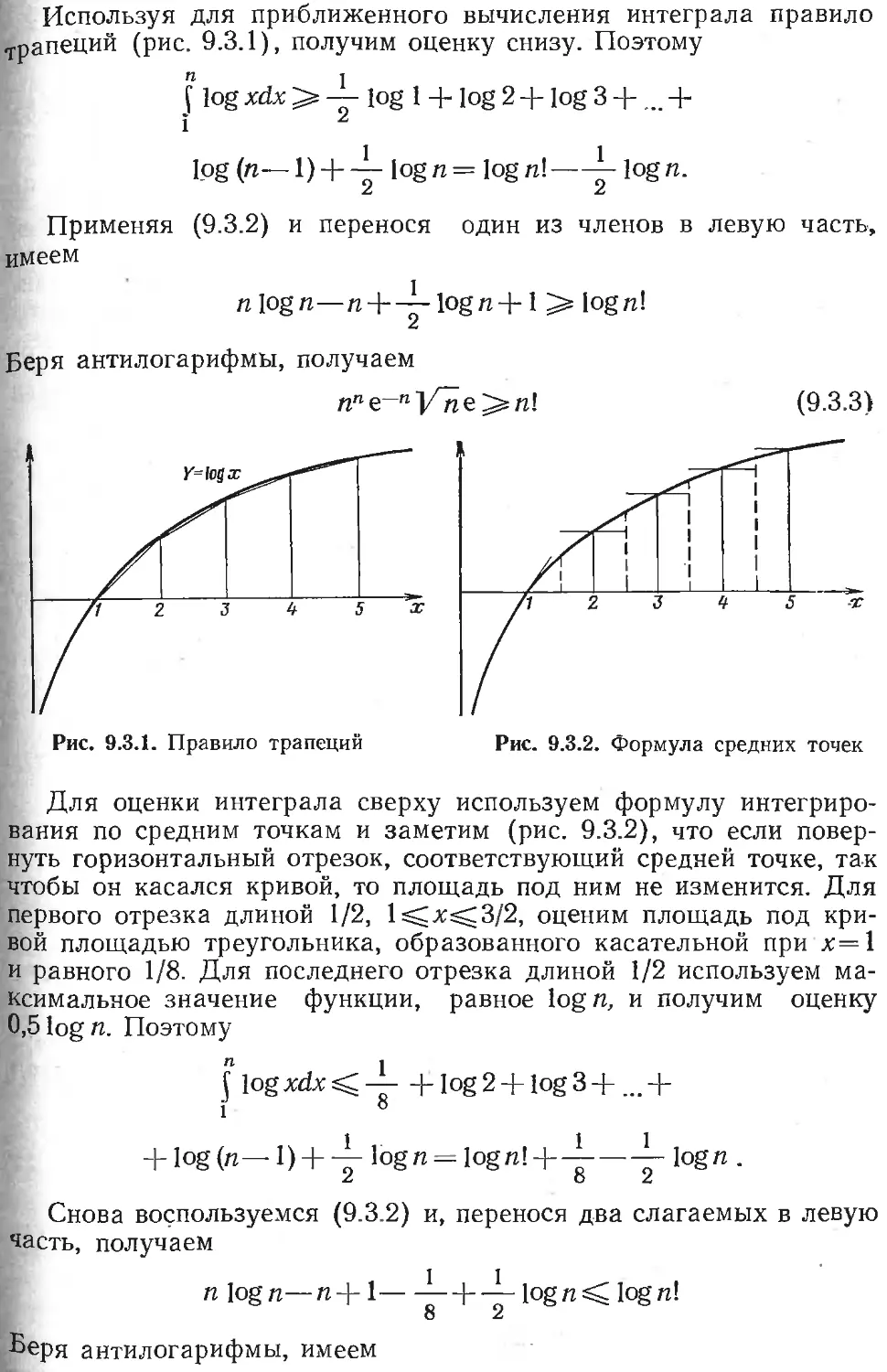

Другой метод передачи резервных символов по системе, в

чем-то эквивалентный предыдущему, состоит в том, что удаленное

устройство переходит в соответствующее состояние при каждом

появлении' специального символа, однако перед совершением дей-

ствия система смотрит, совпадает ли следующий символ с теку-

щим специальным символом. Если совпадение имеется, то устрой-

ство лишь передает этот символ и переходит в нормальное со-

стояние. В противном случае устройство совершает действие, со-

ответствующее этой комайде. Таким образом, при появлении двух

одинаковых резервных символов система сбрасывает первый и

пропускает второй. Если исходное сообщение содержит некоторый

резервный символ два раза подряд, то в посылаемое сообщение

следует вставить еще два символа, и устройство выкинет первый и

третий из них.

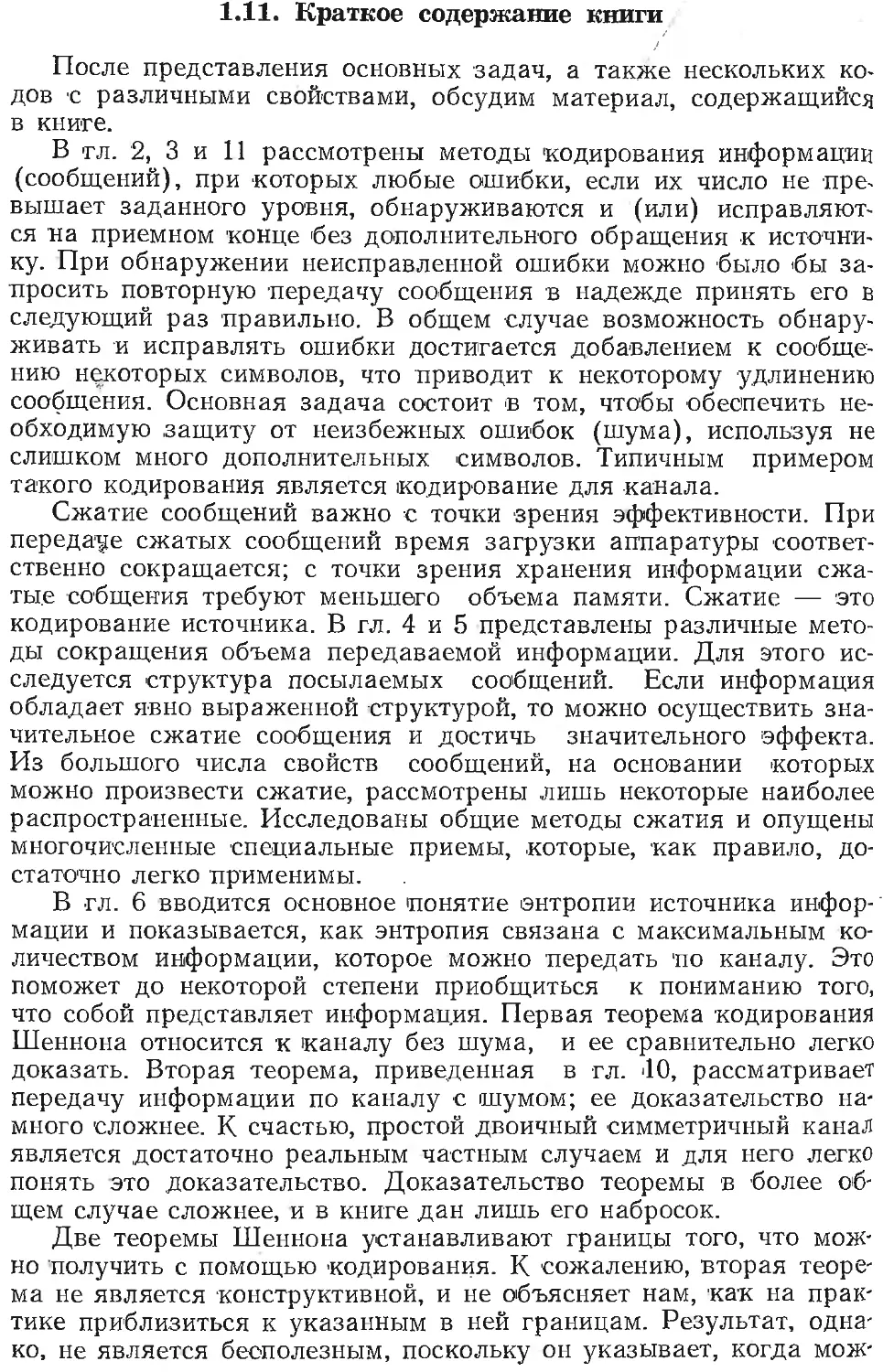

Хотя этот метод кажется довольно сложным для программной

реализации на ЭВМ, теория конечных автоматов указывает путь

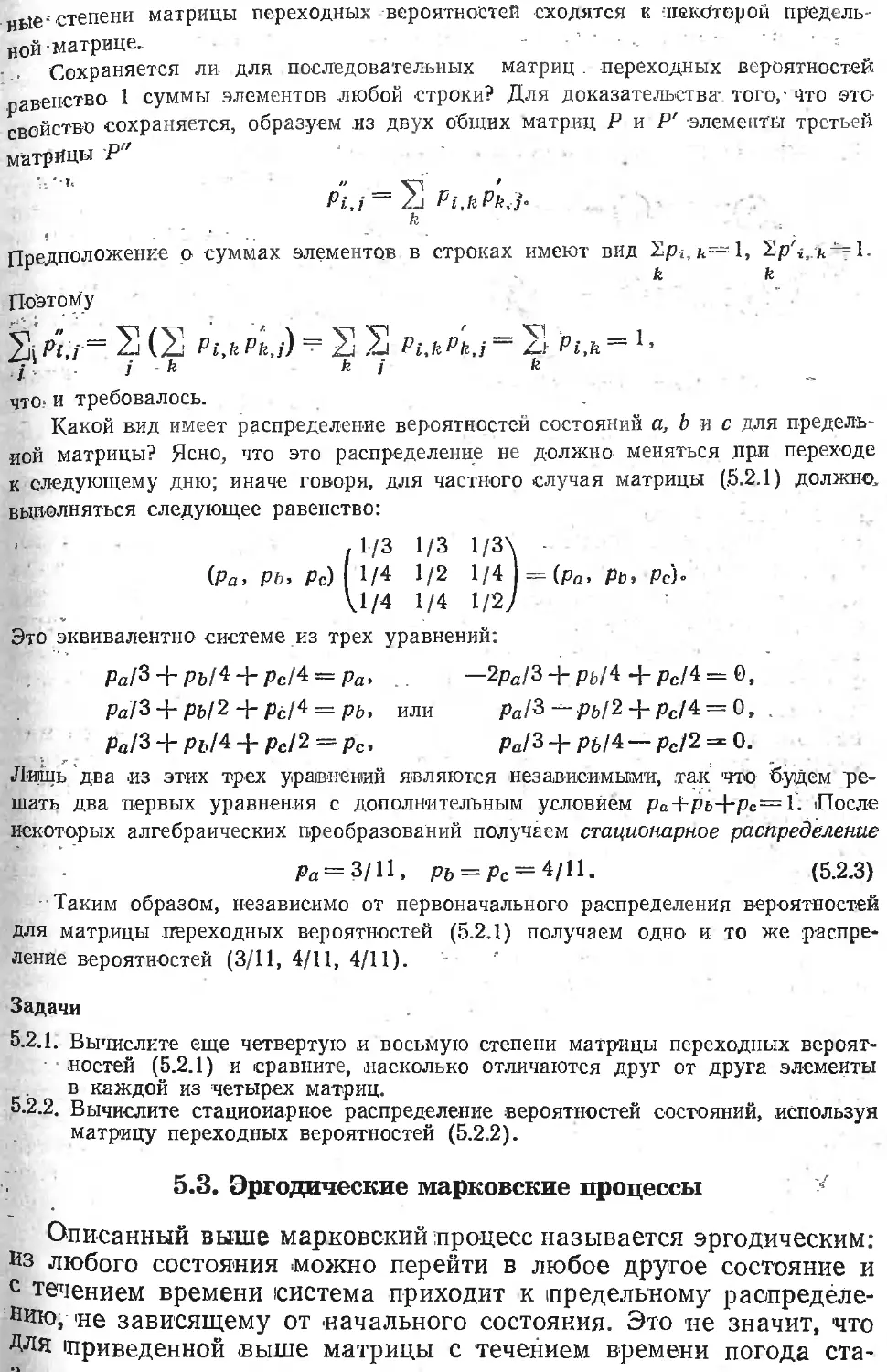

к быстрому решению (рис. 1.10.2). В начальном состоянии проис-

ходит считывание следующего символа, и если он является спе-

циальным, программа запоминает его в регистре и передает уп-

равление программе особого состояния. Программа особого со-

стояния считывает следующий символ и сравнивает его с симво-

лом в регистре. Если два символа совпадают, то специальный

символ копируется и удаляется из входного потока; в противном

случае программа выполняет команду особого состояния. После

этого автомат возвращается в начальное состояние.

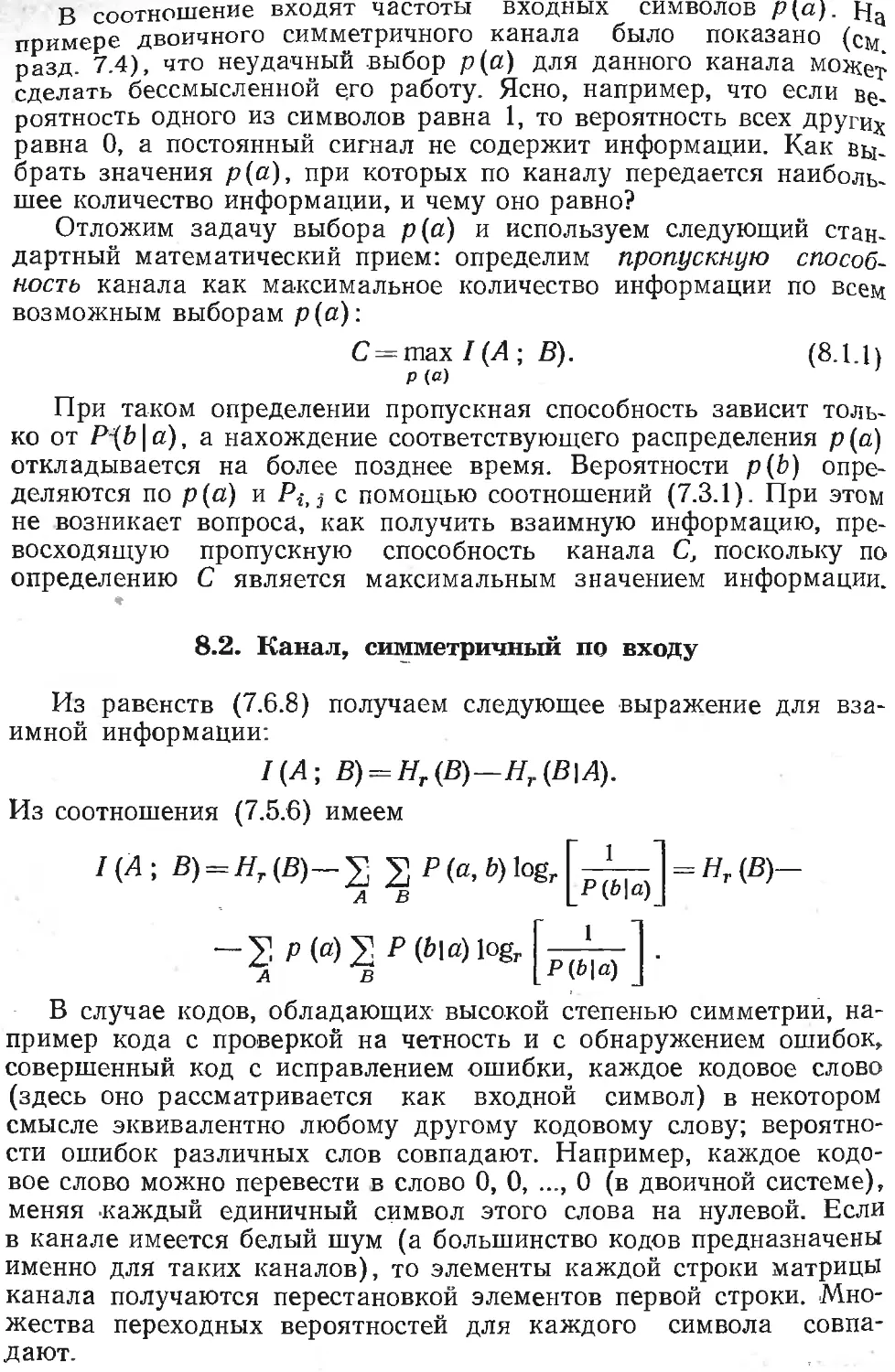

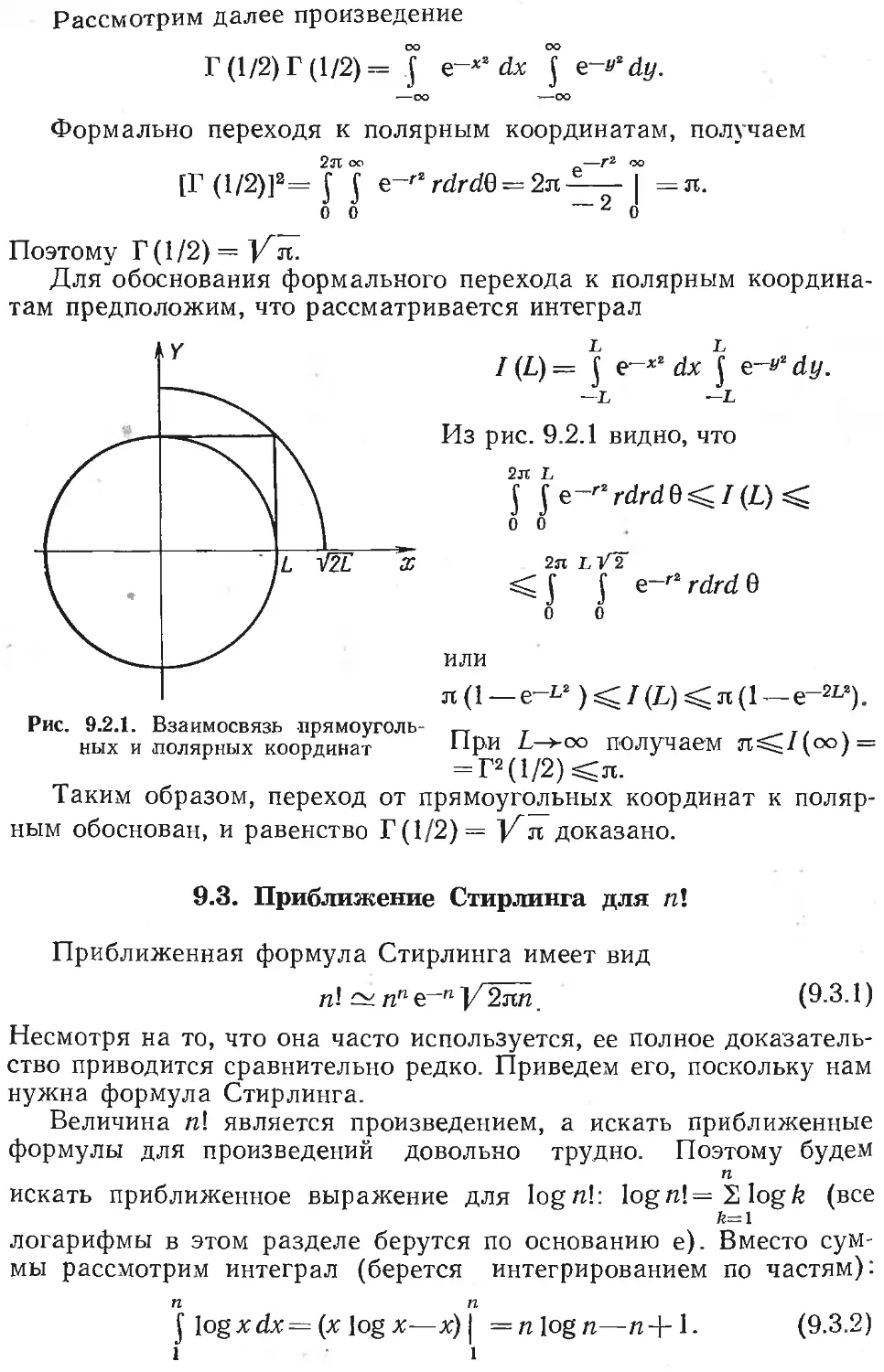

Увалить Убштть

И И И " И ••

^Сообщение к

Копировать Копиг-Лап<ь

На выходе оолуче,х

„ Сообщение"

Рис. 1.10.1. Удаление кавычек

Рис. 1.10.2. Автомат со специаль-

ными символами

В математической логике эта задача называется задачей о

метаязыке и состоит в следующем: как описывать сам язык, в осо-

бенности, когда описание проводится на этом же языке? Обычно

используются интонации (кавычки) для указания, что речь идет

о самом языке, и эти интонации не употребляются в обычном раз-

говоре. Для решения этой общей задачи, возникающей в киберне-

тике и других областях обработки информации, имеются и другие

формальные методы; их также можно приспособить для преодо-

ления подобных возникающих трудностей.

При управлении цифровой ЭВМ ошибки различения уровней

метаязыка служат постоянным источником путаницы. Программа

на языке ФОРТРАН и следующая за ней команда COMPILE при-

надлежит разным языкам. В конце программы следует ставить

Два знака end, из которых один предназначен для метаязыкового

уровня, которому принадлежит COMPILE, и он указывает на

окончание исходной программы, а второй предназначен для фак-

тической программы на языке ФОРТРАН и используется во вре-

мя ее выполнения.

Задачи

1-10.1. Используя схему состояний, подробно опишите, как последовательность

«««Сообщение»»» обрабатывается описанной в тексте системой типа

1102 Ф0РТРАН-

Как послать знак DLE (удалить) через систему с «дублированием спе-

циальных символов»? Поместите его в поток и подробно проследите

за ним.

1.11. Краткое содержание книги

После представления основных задач, а также нескольких ко-

дов с различными свойствами, обсудим материал, содержащийся

в книге.

В гл. 2, 3 и 11 рассмотрены методы кодирования информации

(сообщений), при которых любые ошибки, если их число не пре-

вышает заданного уровня, обнаруживаются и (или) исправляют-

ся на приемном конце без дополнительного обращения к источни-

ку. При обнаружении неисправленной ошибки можно было бы за-

просить повторную передачу сообщения в надежде принять его в

следующий раз правильно. В общем случае возможность обнару-

живать и исправлять ошибки достигается добавлением к сообще-

нию некоторых символов, что приводит к некоторому удлинению

сообщения. Основная задача состоит в том, чтобы обеспечить не-

обходимую защиту от неизбежных ошибок (шума), используя не

слишком много дополнительных символов. Типичным примером

такого кодирования является кодирование для канала.

Сжатие сообщений важно с точки зрения эффективности. При

передаче сжатых сообщений время загрузки аппаратуры соответ-

ственно сокращается; с точки зрения хранения информации сжа-

тые собщения требуют меньшего объема памяти. Сжатие — это

кодирование источника. В гл. 4 и 5 представлены различные мето-

ды сокращения объема передаваемой информации. Для этого ис-

следуется структура посылаемых сообщений. Если информация

обладает явно выраженной структурой, то можно осуществить зна-

чительное сжатие сообщения и достичь значительного эффекта.

Из большого числа свойств сообщений, на основании которых

можно произвести сжатие, рассмотрены лишь некоторые наиболее

распространенные. Исследованы общие методы сжатия и опущены

многочисленные специальные приемы, которые, как правило, до-

статочно легко применимы.

В гл. 6 вводится основное понятие энтропии источника инфор-

мации и показывается, как энтропия связана с максимальным ко-

личеством информации, которое можно передать по каналу. Это

поможет до некоторой степени приобщиться к пониманию того,

что собой представляет информация. Первая теорема кодирования

Шеннона относится к каналу без шума, и ее сравнительно легко

доказать. Вторая теорема, приведенная в гл. 40, рассматривает

передачу информации по каналу с шумом; ее доказательство на-

много сложнее. К счастью, простой двоичный симметричный канал

является достаточно реальным частным случаем и для него легко

понять это доказательство. Доказательство теоремы в более об-

щем случае сложнее, и в книге дан лишь его набросок.

Две теоремы Шеннона устанавливают границы того, что мож-

но получить с помощью кодирования. К сожалению, вторая теоре-

ма не является конструктивной, и не объясняет нам, как на прак-

тике приблизиться к указанным в ней границам. Результат, одна-

ко, не является бесполезным, поскольку он указывает, когда мож-

но значительно улучшить системы передачи сигналов и когда мож-

но достичь лишь небольших улучшений.

В теории информации определение канала часто бывает доста-

точно абстрактным, что приводит к необходимости других спосо-

бов определения центрального понятия пропускной способности.

В приложении А кратко показано, как на практике измеряется

пропускная способность канала в -системе передачи сигналов.

Напомним читателю, что хотя часто используется терминоло-

гия, относящаяся к «передаче сигналов из одного места в другое»,

все сказанное можно применить к «передаче сигналов от одного

момента времени до другого» в некоторой системе памяти. В этом

случае первая теорема Шеннона (без шума) часто становится 'бо-

лее существенной.

Традиция в изложении теории кодирования и теории информа-

ции состоит в том, чтобы придерживаться, по возможности, наи-

более общего и элегантного пути, часто весьма абстрактного, ис-

пользующего много математики и далекого от практических аспек-

тов. Такой подход не является необходимым, поэтому будем ре-

гулярно останавливаться и показывать, как обсуждаемые вопро-

сы связаны со здравым смыслом с нуждами практики, и чем они

могут быть полезны при проектировании будущих систем. Попы-

таемся также приводить доказательства, которые, по возможности,

интуитивно очевидны, а не просто элегантны с математической

точки зрения. В процессе изложения подчеркиваются многочислен-

ные небольшие практические детали, важные при проектировании

системы в целом.

Уточним, наконец, принятый в книге подход. В настоящее вре-

мя используется много разных систем передачи сигналов и еще

больше их будет использоваться в ближайшем будущем. Поэтому

нецелесообразно рассматривать их одну за другой. Следует при-

нять более широкий, общий подход и сконцентрировать внимание

на таких основных понятиях, которые представляются наиболее

существенными для понимания уже имеющихся и -будущих систем

передачи сигналов. Действительно, такой подход является един-

ственно разумным в любой быстро развивающейся научной обла-

сти. Подход, основанный на изучении отдельных примеров, приво-

дит к тому, что новая система ставит студента в тупик. Таким

образом, наше изложение, по необходимости, часто является аб-

страктным и не содержит описания многих деталей существующих

систем.

Глава 2

Коды с обнаружением ошибок

2.1. Для чего нужны коды с обнаружением ошибок?

Из опыта известно, что высоконадежное оборудование нелегко

построить. Для определения того, что значит высоконадежное,

рассмотрим, сколько вычислений современная ЭВМ производит в

течение 1 ч. При скорости 1 оп/мкс ЭВМ производит 3,6-109 оп/ч,

а каждая операция состоит из многих действий. Для сравнения

укажем, что в 100 годах (что с большой вероятностью превышает

срок вашей жизни) содержится менее 3,16-109 с. Аналогично, на-

дежные системы передачи должны состоять из очень надежных

отдельных компонентов. Надежность при передаче слов живого

языка существенно отличается от надежности при передаче про-

грамм ЭВМ. Отсюда вытекает важность обнаружения ошибок.

Кроме того, как уже отмечалось, обнаружение ошибок 'весьма по-

лезно для обеспечения высококачественного обслуживания.

В случаях, когда возможно повторение, часто бывает доста-

точно лйшь обнаружить ощибку. После обнаружения ошибки со-

общение, операция или другое действие повторяются еще раз и

при некоторой удаче второе (или, возможно, третье) повторение

будет верным (см. разд. 2.5).

Нельзя обнаружить ошибку, если любой принятый символ

(или их множество) может служить сообщением. Ошибки можно

обнаружить только в том случае, если на возможные сообщения

наложены некоторые ограничения. Задача состоит в том, чтобы

свести ограничения на возможные сообщения к достаточно про-

стым. На практике «простой» обычно означает «легко вычисли-

мый». В этой главе рассмотрена задача построения кодов, позво-

ляющих на приемном конце обнаружить любую одиночную ошиб-

ку. В гл. 3 рассмотрена задача исправления на приемном конце

ошибок, возникающих при передаче сообщения.

2.2. Простые проверки на четность

Простейший способ кодирования двоичного сообщения для

обнаружения ошибок состоит в подсчете числа 1 в сообщении и

добавлении еще одного двоичного символа с тем, чтобы во всем

сообщении содержалось четное число 1. Таким образом, к (п—1)

символам сообщения добавляется n-я позиция для проверки на

четность. На приемном конце производится подсчет числа 1, и не-1

четное число 1 во всех п позициях указывает на появление по

крайней мере одной ошибки.

Ясно, что такой код не может обнаруживать двойные ошибки.

Однако нечетное число ошибок обнаружить можно. Если предпо-

ложить, что, во-первых, вероятность ошибки в каждой двоичной

позиции равна некоторому числу р и, во-вторых, ошибки в различ-

ных позициях независимы, то при п, много меньших 1/р, вероят-

ное число одиночных ошибок равно пр. Вероятность двойной

ошибки примерно равна п(п—1)р2/2, т. е. примерно половине

квадрата одиночной ошибки. Поэтому оптимальная длина прове-

ряемого сообщения зависит как от требуемого уровня надежности

(вероятности того, что двойная ошибка останется необнаружен-

ной), так и от вероятности р единичной ошибки на любой пози-

ции. Дальнейшие подробности излагаются в разд. 2.4.

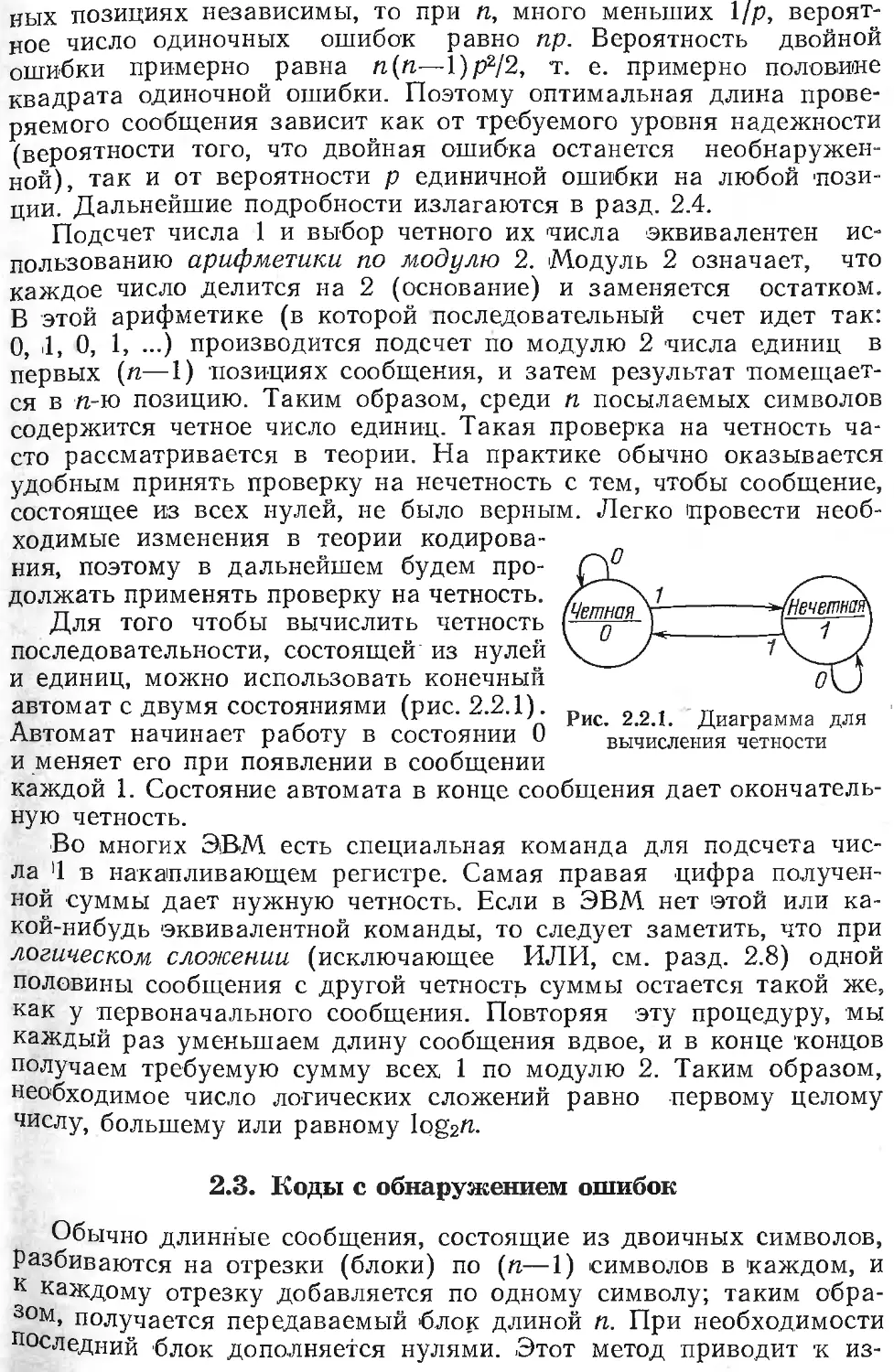

Подсчет числа 1 и выбор четного их числа эквивалентен ис-

пользованию арифметики по модулю 2. Модуль 2 означает, что

каждое число делится на 2 (основание) и заменяется остатком.

В этой арифметике (в которой последовательный счет идет так:

О, .1, 0, 1, ...) производится подсчет по модулю 2 числа единиц в

первых (п—1) позициях сообщения, и затем результат помещает-

ся в п-ю позицию. Таким образом, среди п посылаемых символов

содержится четное число единиц. Такая проверка на четность ча-

сто рассматривается в теории. На практике обычно оказывается

удобным принять проверку на нечетность с тем, чтобы сообщение,

состоящее из всех нулей, не было верным. Легко провести необ-

ходимые изменения в теории кодирова-

ния, поэтому в дальнейшем будем про-

должать применять проверку на четность.

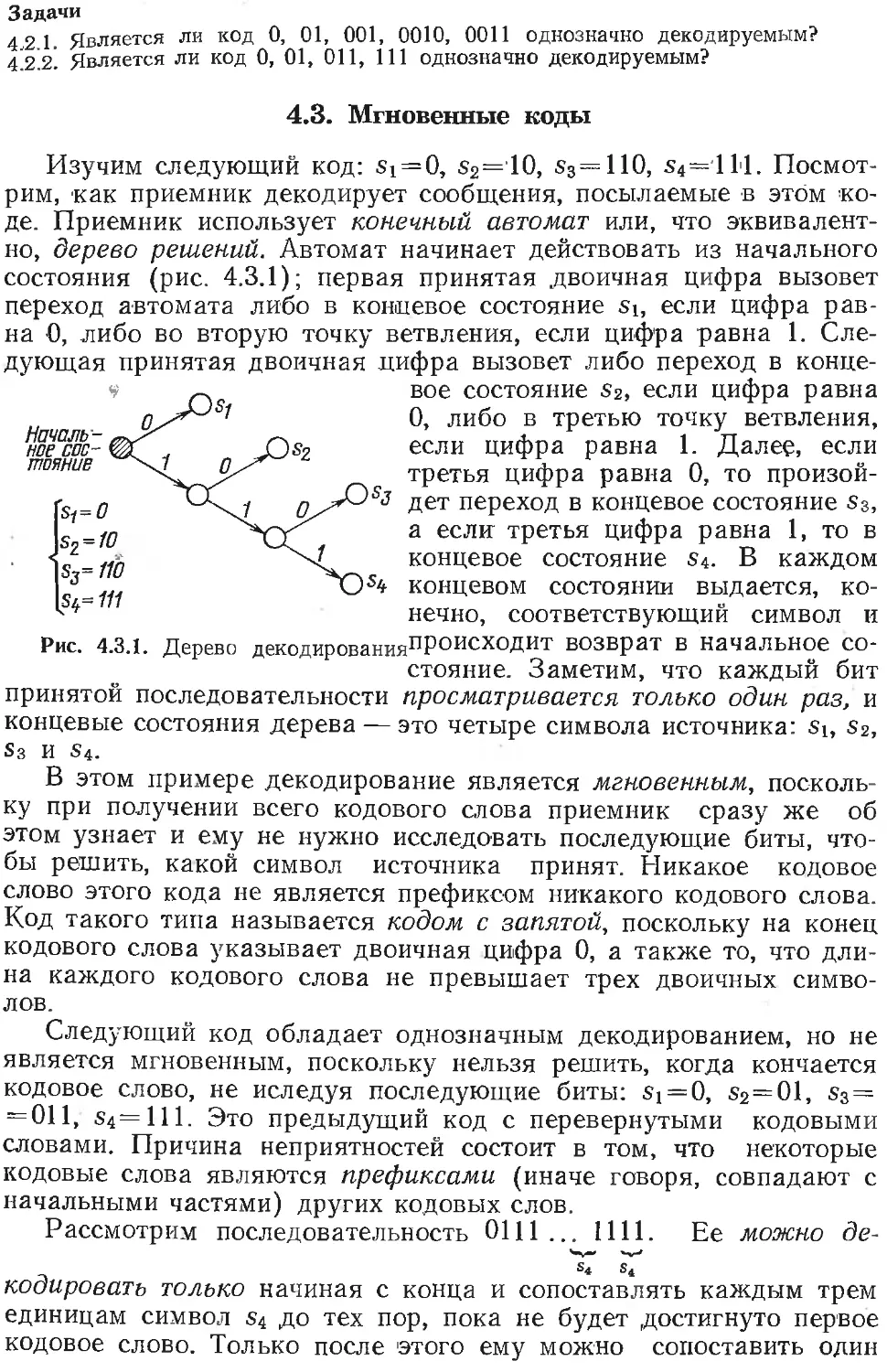

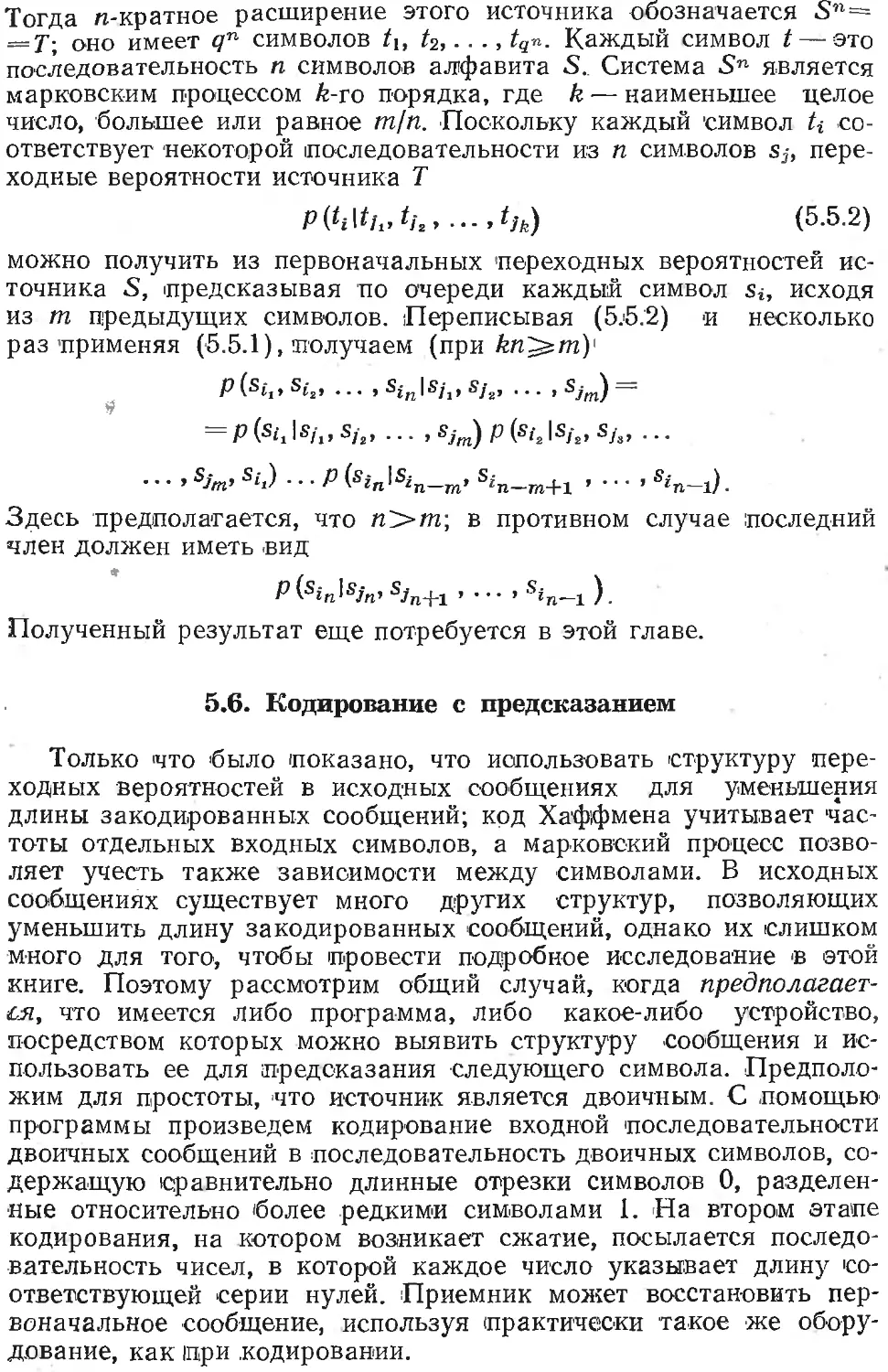

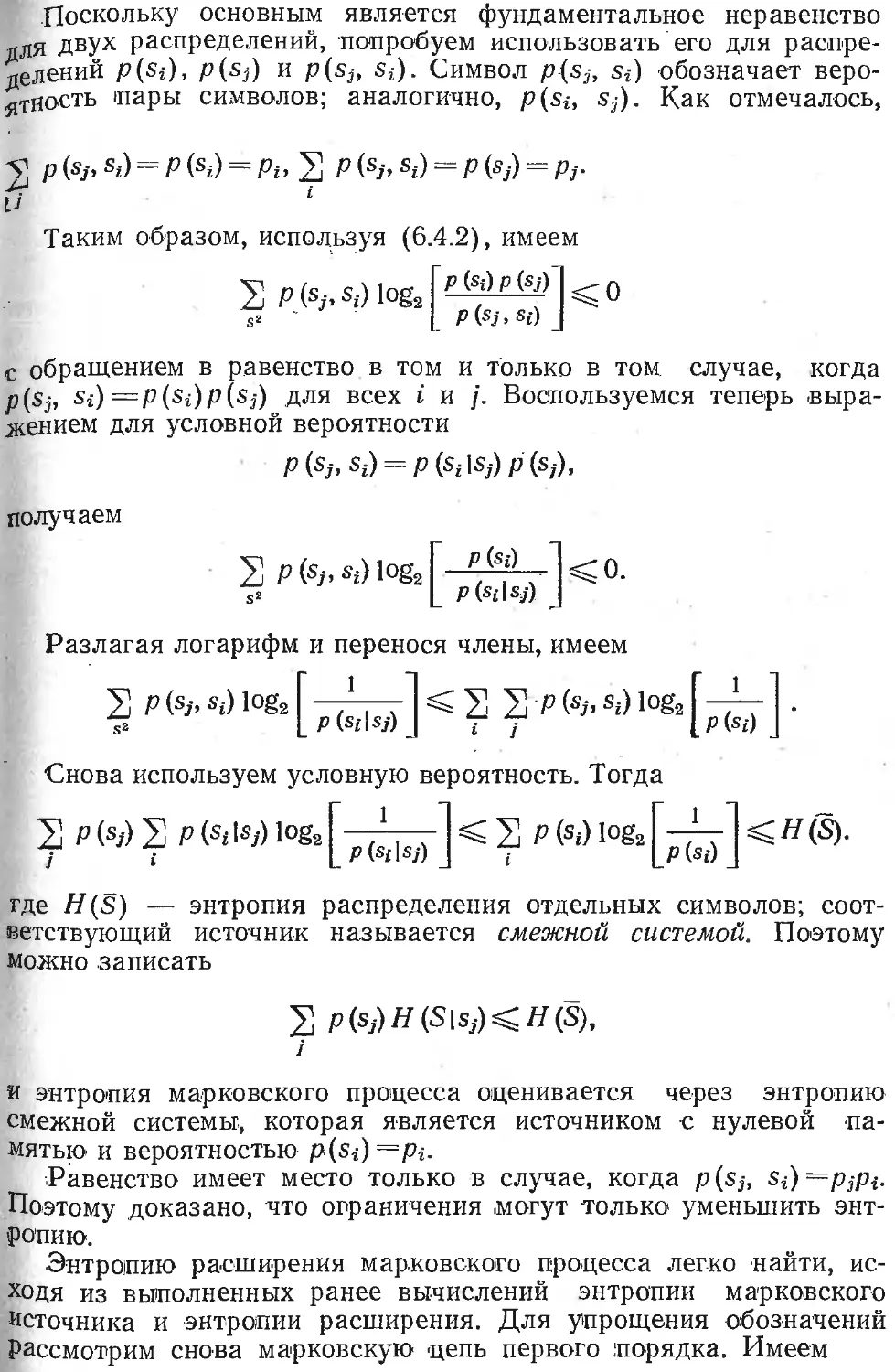

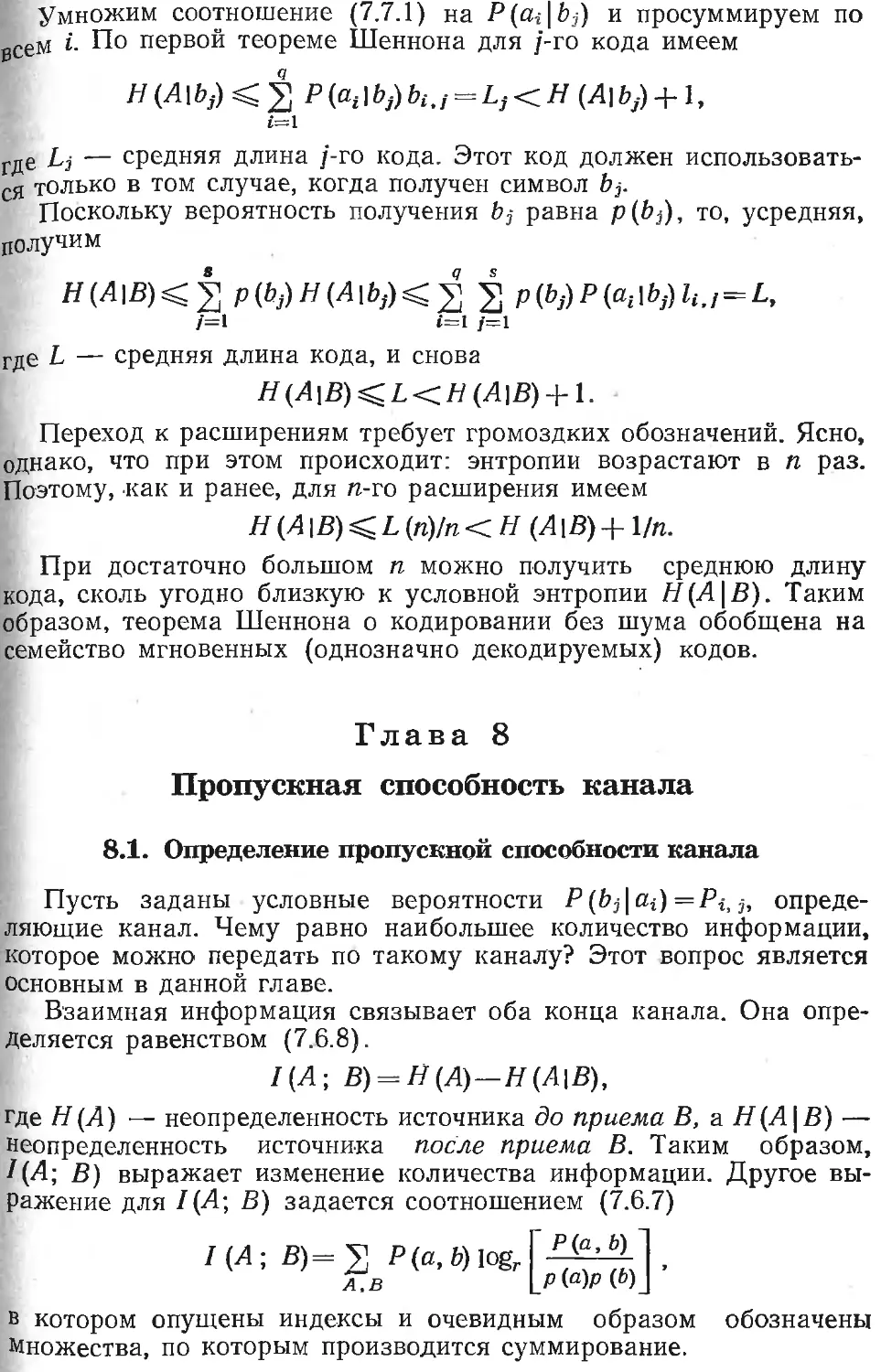

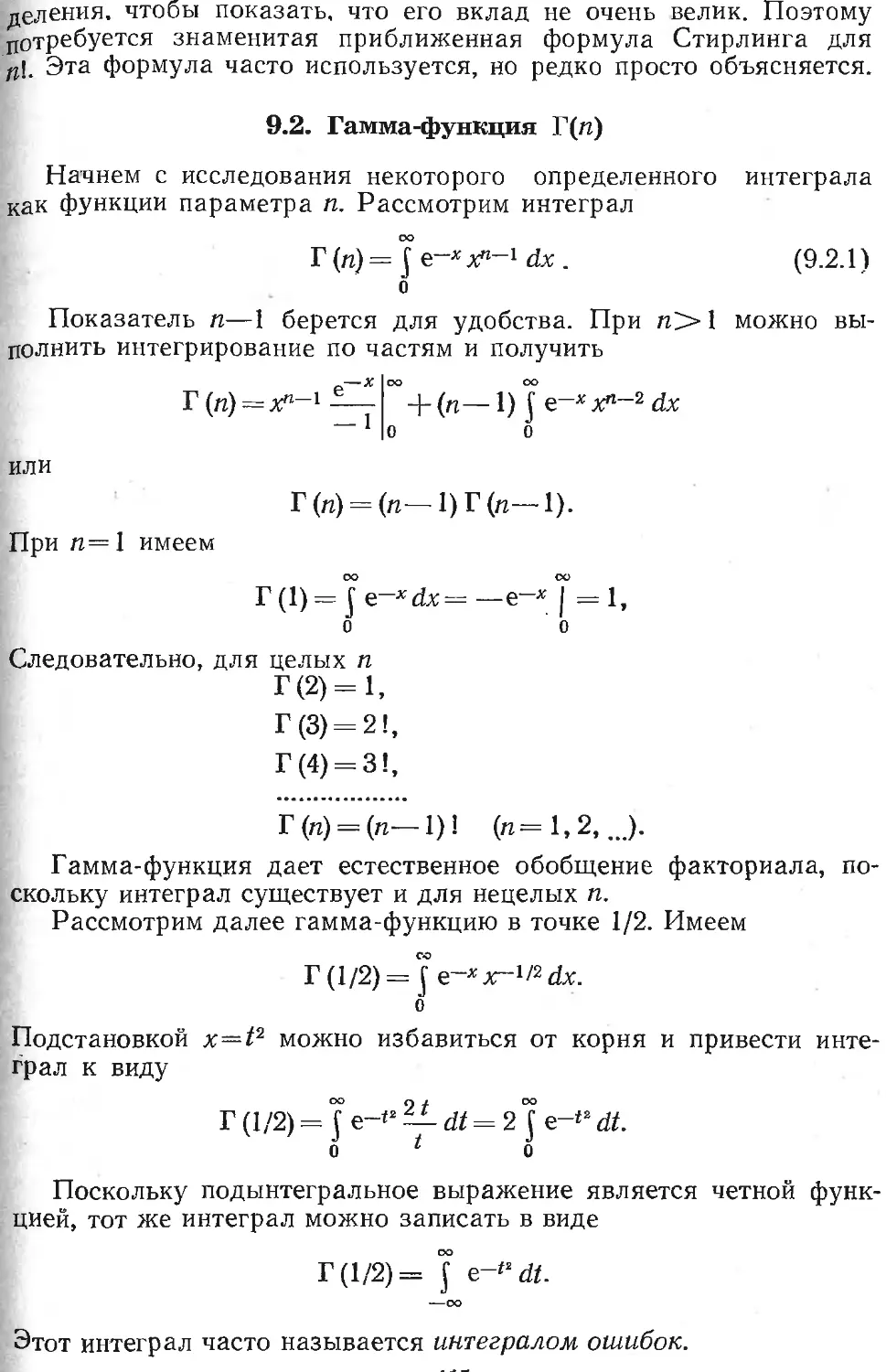

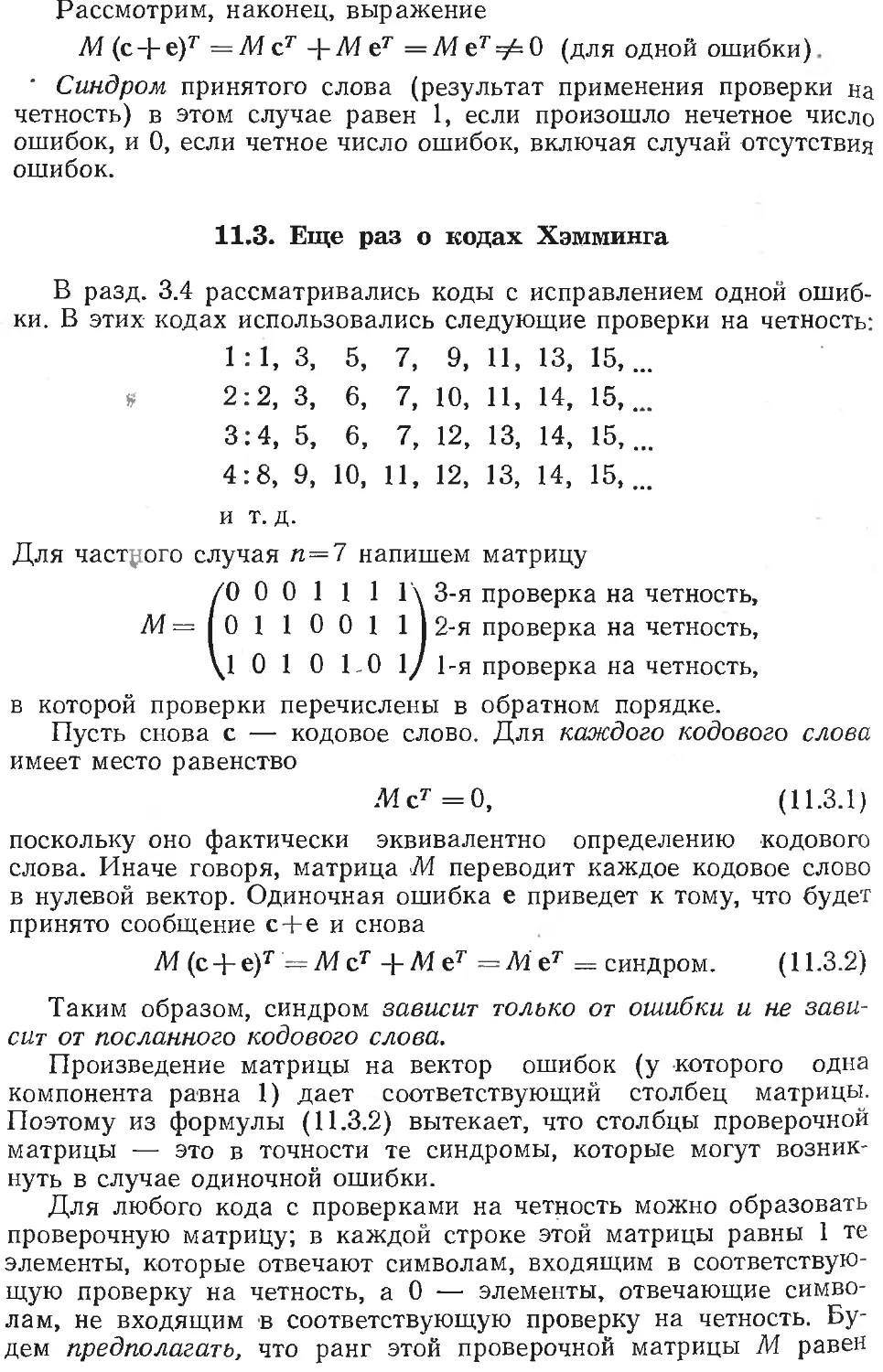

Для того чтобы вычислить четность

последовательности, состоящей’ из нулей

и единиц, можно использовать конечный

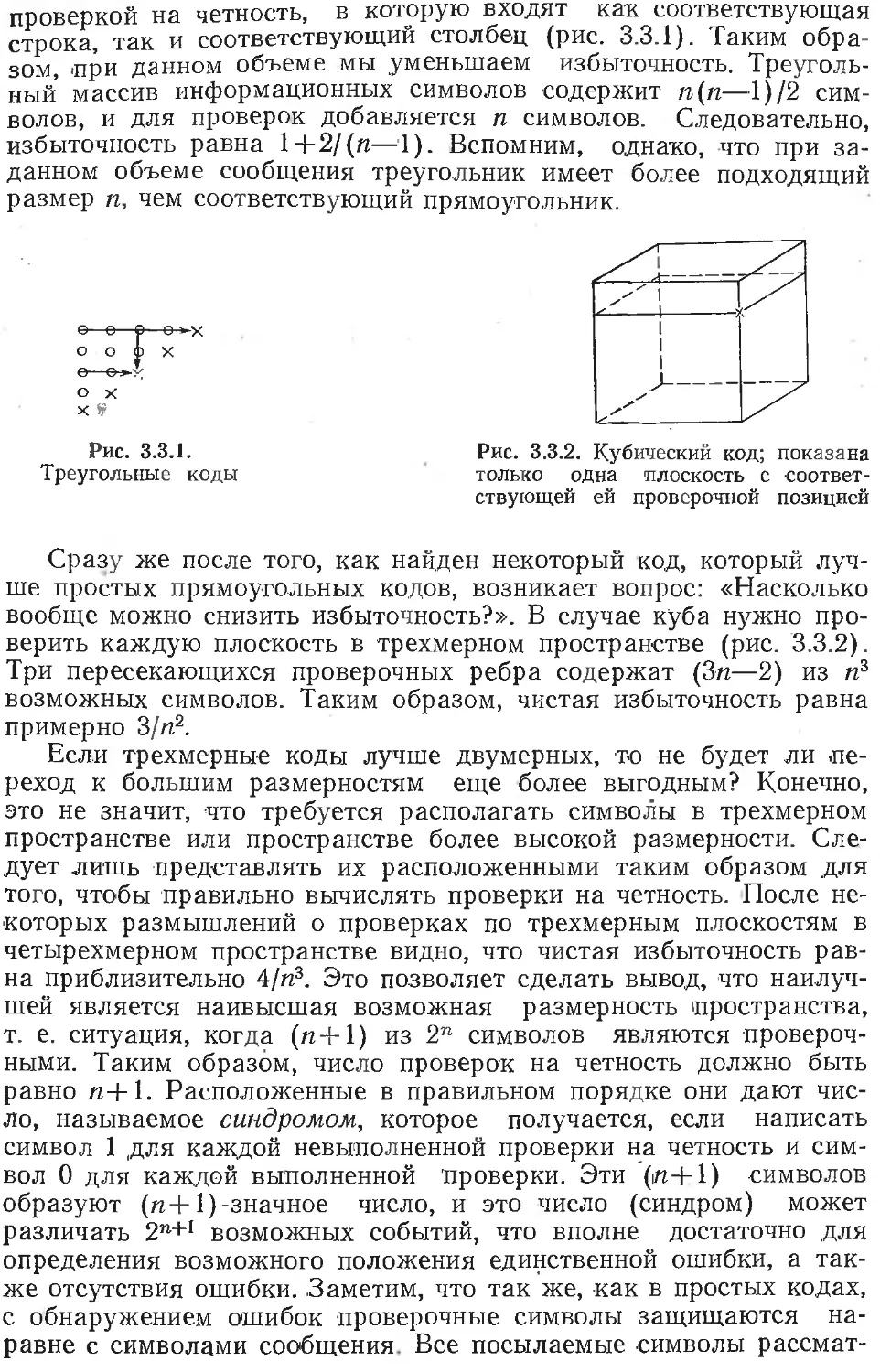

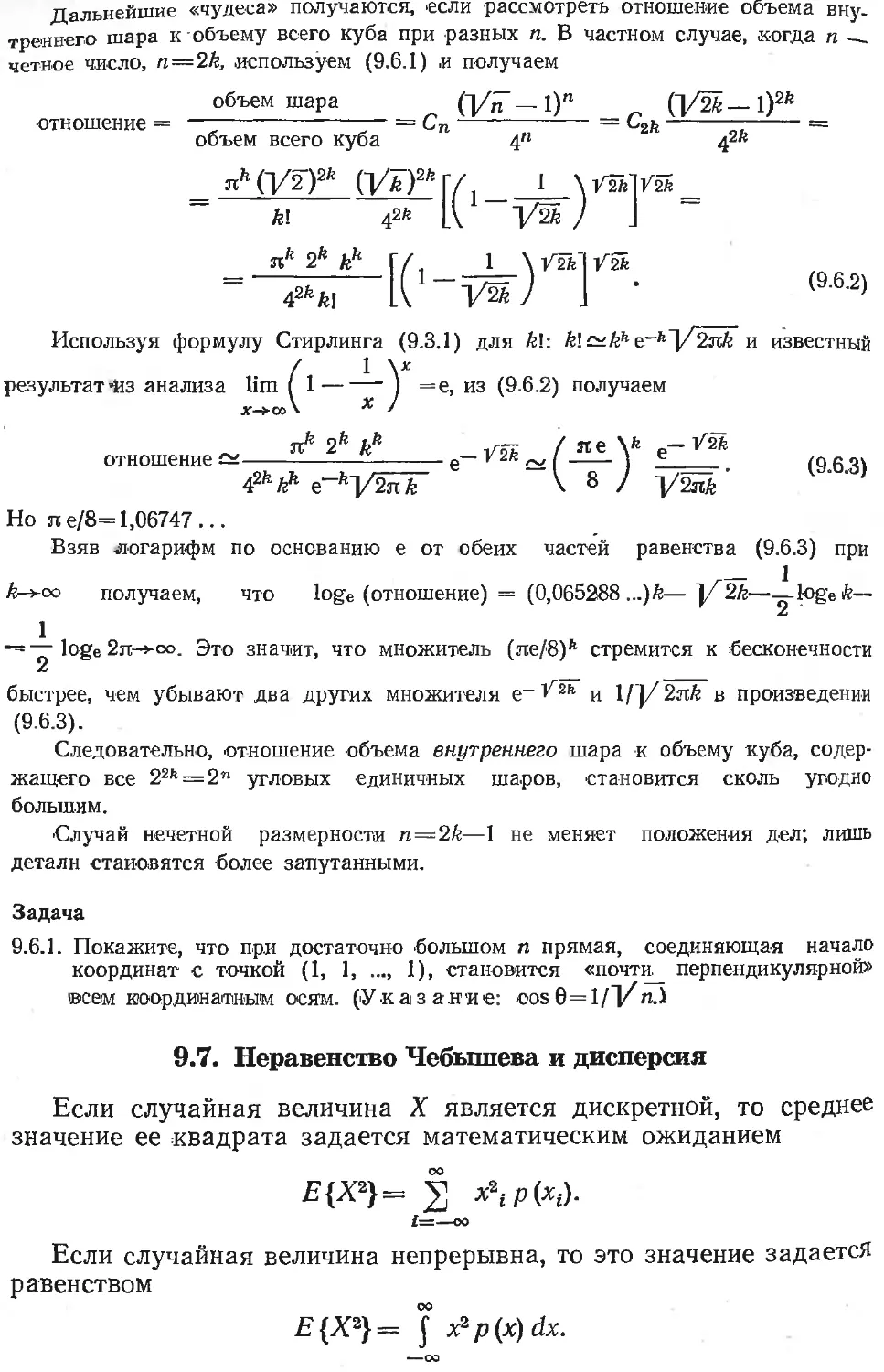

автомат с двумя состояниями (рис. 2.2.1).

Автомат начинает работу в состоянии О

и меняет его при появлении в сообщении

Рис. 2.2.1. Диаграмма для

вычисления четности

каждой 1. Состояние автомата в конце сообщения дает окончатель-

ную четность.

Во многих ЭВМ есть специальная команда для подсчета чис-

ла '1 в накапливающем регистре. Самая правая цифра получен-

ной суммы дает нужную четность. Если в ЭВМ нет этой или ка-

кой-нибудь эквивалентной команды, то следует заметить, что при

логическом сложении (исключающее ИЛИ, см. разд. 2.8) одной

половины сообщения с другой четность суммы остается такой же,

как у первоначального сообщения. Повторяя эту процедуру, мы

каждый раз уменьшаем длину сообщения вдвое, и в конце концов

получаем требуемую сумму всех 1 по модулю 2. Таким образом,

необходимое число логических сложений равно первому целому

числу, большему или равному log2n.

2.3. Коды с обнаружением ошибок

Обычно длинные сообщения, состоящие из двоичных символов,

Разбиваются на отрезки (блоки) по (п—1) символов в каждом, и

к каждому отрезку добавляется по одному символу; таким обра-

зом, получается передаваемый блок длиной п. При необходимости

последний блок дополняется нулями. Этот метод приводит к из-

быточности, равной п/(п—1) = 1 + 1/(п—1). Избыточность опреде-

ляется как отношение числа используемых двоичных символов к

минимально необходимому числу символов. Чистая избыточность

равна 1/(п—1).

Ясно, что для получения низкой избыточности следует приме-

нять длинные сообщения. Однако для получения высокой надеж-

ности 1предпочтительнее короткие сообщения. Таким образом, вы-

бор длины п посылаемых блоков сообщения является результатом

компромисса между двумя противоположными силами.

Код 2-из-5, упомянутый в разд. 1.8, является примером кода с

п=15, использующего проверку на четность. Код ван Дюрена

З-из-7 — 'пример кода, использующего проверку на нечетность.

Ни в одном из кодов не применяются все возможные блоки. Дру-

гим примером такого кода служит подсчет числа слов, иногда ис-

пользуемого при передаче телеграмм.

На практике для обнаружения ошибок применяется много

других простых кодов такого типа. Например, при записи содер-

жимого памяти на диск, барабан или ленту к множеству переда-

ваемых слов в качестве контрольного слова часто добавляется

логическая сумма всех слов. Аппаратная реализация этого метода

описана в [115].

2.4. Независимые ошибки — белый шум

Как указывалось выше, в обычной модели ошибок предпола-

гается, что, во-первых, вероятность ошибки в каждой позиции со-

общения равна одному и тому же числу р и, во-вторых, ошибки в

различных позициях независимы. Такая ситуация называется бе-

лым шумом по аналогии с белым светом, в котором по неточно-

му предположению с одинаковой .интенсивностью содержатся все

частоты, различаемые глазом человека. В этом случае теория

достаточно проста для понимания. Отметим, что часто на практи-

ке ошибки являются более вероятными в одних позициях, кроме

того, часто ошибки группируются в пакеты и не являются незави-

симыми. Например, корреляция между ошибками возникает при

общем электропитании, а также при близких вспышках молнии

(см. разд. 2.6).

Следует отметить, что вследствие быстрого развития техники

в процессе проектирования обычно невозможно точно знать, ка-

кие комбинации ошибок встретятся при работе устройства. По-

этому белый шум часто является разумным предположением.

В случае белого шума вероятность отсутствия ошибок в п по-

зициях равна (1— р)п. Вероятность ровно одной ошибки в п пози-

циях равна пр(1—р)п~{- Вероятность ровно k ошибок задается

/?-м членом разложения бинома

1 = [(1— р) + р]п =(1— РУ1 +пр(1—руг~1 +

+ п(п— 1)р2(1— р)п~2 /2 + ...+рп.

Например, вероятность ровно двух ошибок равна

п (п— 1) р2 (1 — р)п~2 /2.

(Вероятность четного числа ошибок (0, 2, 4, ...) можно полу-

чить, сложив два приведенных ниже разложения бинома и разде-

лив результат на 2:

1 = [(1 -р) + рр = 2 С (п, k) pk (1 —,

fe=0

Ki— p)—pp =2 (—ipc(n, &)pft(i—pp-fe,

k=0

i j_(i_9 nl" [n/2l

—— = 2 C(n, 2 m) p2m (1 — p)«-2m. ^2.4.1)

2--------------------------------------------------m=0

Квадратные скобки в (2.4.1) означают целую часть заключенного

в них числа. Вероятность нечетного числа ошибок (которые всег-

да обнаруживаются) получается вычитанием этого выражения

из 1.

Вероятности отсутствия ошибок соответствует первый член в

сумме (i2.4.1). Поэтому для нахождения вероятности необнаружи-

ваемых ошибок нужно отбросить в (2.4.1) первый член и полу-

чить

[п/2]

2 С(п, 2т)р2т(1 —-р)п~2т. (2.4.2)

т=1

Обычно заметный вклад вносит лишь несколько ‘первых членов

этой суммы.

Задачи

2.4.1. Найдите вероятность отсутствия ошибок при р=0,001 и п=100. Ответ:

ехр (-1/Ю).

2.4.2. Найдите вероятность необнаруживаемых ошибок при р=0,001 и п=100.

2.4.3. Пусть р=0,01, и вероятность необнаруживаемых ошибок должна быть

равной 0,005. Найдите наибольшую длину п, которую можно использовать.

Ответ: п=10 и почти п=11.

2.4.4. Решите задачу 2.4.1 при малом р и произвольном п. Ответ: ехр (—пр).

2.5. Повторная передача сообщения

После обнаружения ошибки часто можно повторить передачу

сообщения, вычисление или какой-либо другой из выполненных

процессов. Например, в ЭВМ фирмы Bell (отделение Bell Relay

Computers) для представления десятичных цифр используется

код 2-из-5 и при обнаружении ошибки 'предпринимается вторая и

Даже третья попытка вычислений. В случае, когда даже после

третьей попытки сообщение остается неприемлемым, выполнение

текущей задачи прерывается, и ЭВМ переходит к следующей за-

даче в надежде, что ее неисправная часть не будет применяться

при выполнении новой задачи.

При считывании с магнитной ленты принято использовать, по

крайней мере, код с обнаружением ошибок и в случае, когда про-

верки на четность не выполнены, производится повторное считыва-

ние. Число повторных попыток зависит от принятой модели оши-

бок. Если предположить, что произошла малая потеря намагни-

ченности, то можно надеяться, что при повторной попытке счи-

тывание будет произведено правильно. Если, однако, допустить,

что ошибка явилась результатом более стойкой неисправности, то

скорее всего, повторные попытки будут неудачными до тех пор,

пока не появится еще одна ошибка, так что проверка на четность

окажется выполненной. Следовательно, вместо правильного сооб-

щения будет получено сообщение с двумя ошибками! Таким об-

разом, стратегия «при обнаружении ошибки выполнять одну или

несколько повторных попыток» оказывается разумной только если

ожидаемые ошибки являются временными.

Проверки на четность уже давно используются в ЭВМ как на

аппаратурном, так и на программном уровнях [15]. Например, на

первых порах в случае ненадежного накопителя на магнитном ба-

рабане каждая операция записи сопровождалась логическим сло-

жением содержимого всех регистров, записываемого на барабан.

Сумма запоминалась в последнем регистре блока’ на барабане.

Затем производилось считывание с барабана для проверки пра-

вильности записи. Только после этого записанная информация

сбрасывалась из регистров памяти ЭВМ. Затем выполнялось счи-

тывание с барабана, и снова проводилась проверка на четность

(путем вычисления логической суммы всех регистров), которая

должна была давать тождественный нуль. В случае невыполнения

проверки на четность осуществлялось повторное считывание. Ме-

тод основывался на том, что для логического сложения х+х=0.

2.6. Простые коды для обнаружения пакетов ошибок

Ошибки (шум) в принятом сообщении чаще группируются в

пакеты, а не в отдельные изолированные позиции. Вспышки мол-

нии, флуктуации питающего напряжения, дефекты магнитной по-

верхности являются типичными причинами, приводящими к воз-

никновению пакетов ошибок.

Предположим, экспериментально получена максимальная дли-

на L пакета ошибок, который должен быть обнаружен. Для про-

стоты примем, что длина пакета L совпадает с длиной слова в

ЭВМ (легко внести изменения, необходимые для рассмотрения

других случаев). В этих условиях нужно выбрать подходящий код

с обнаружением ошибок 5(или .код с исправлением ошибок, как в

гл. 3), и вместо вычисления проверок на четность по битам сле-

дует вычислить проверку на четность по словам. В самом дёле,

работа со словами, а не с битами приводит к L независимым (пе-

ремежающимся) кодам, по одному для каждого двоичного симво-

ла в слове.

Если пакет перекрывает конец одного слова и начало другого,

то по-прежнему ни в каком коде не встретятся две ошибки, по-

скольку, по предположению, длина k пакета удовлетворяет усло-

вию

Таким образом, можно передавать сообщения по каналу с па-

кетами ошибок, если есть возможность определить конфигурацию

шумов и соответственно организовать проверки. Надежное аппа-

ратурное обеспечение описано в [15].

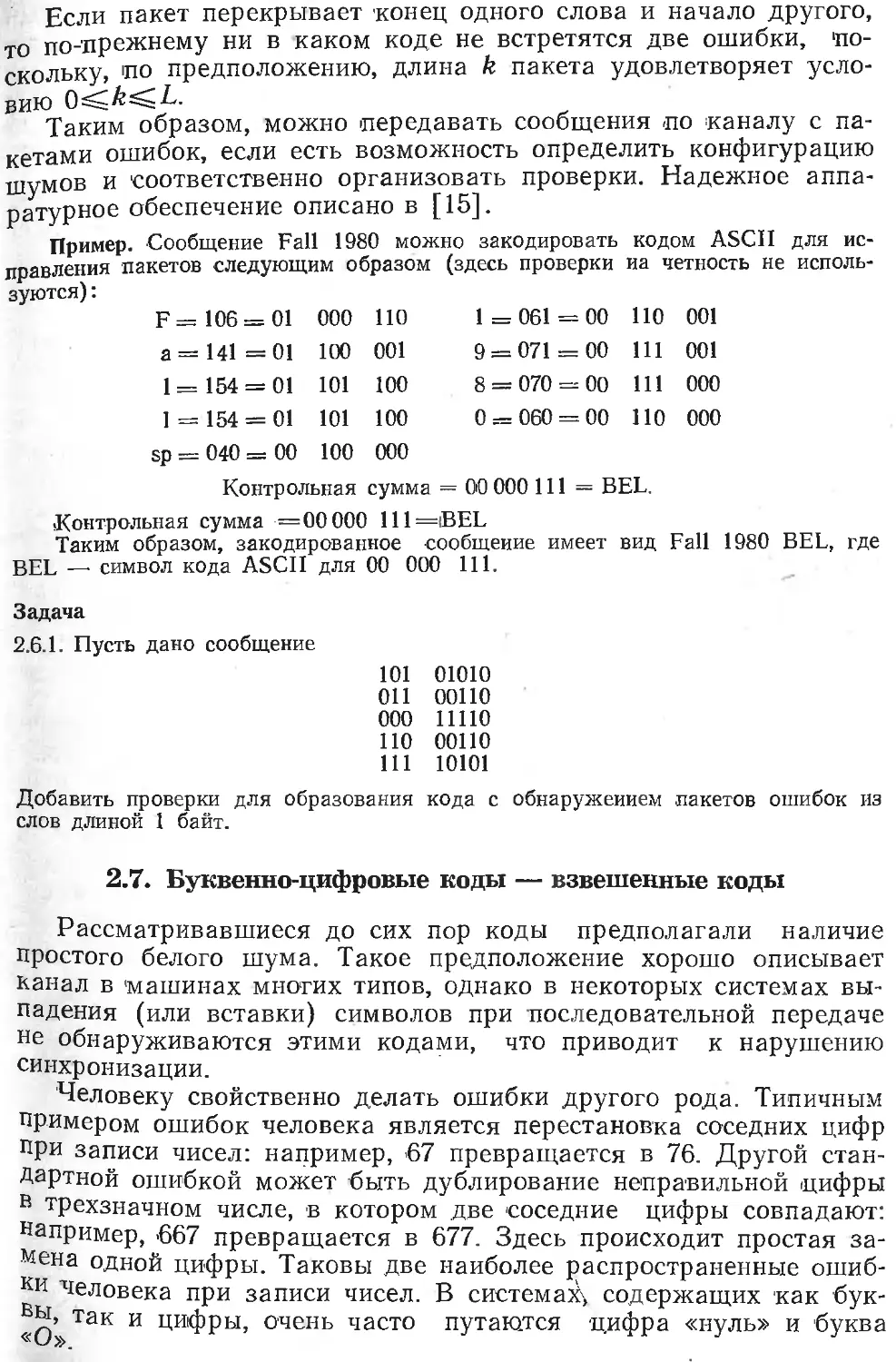

Пример. Сообщение Fall 1980 можно закодировать кодом ASCII для ис-

правления пакетов следующим образом (здесь проверки иа четность не исполь-

зуются) :

F = 106 = 01 000 НО 1 = 061 = 00 110 001

а= 141 =01 100 001 9 = 071 = 00 111 001

1 = 154 = 01 101 100 8 = 070 = 00 111 000

1 = 154 = 01 101 sp = 040 = 00 100 Контрольная 100 000 сумма = 0 = 060 = 00 ПО 00 000 111 = BEL. 000

•Контрольная сумма =00 000 111=iBEL

Таким образом, закодированное сообщение имеет вид Fall 1980 BEL, где

BEL —• символ кода ASCII для 00 000 111.

Задача

2.6.1. Пусть дано сообщение

101 01010

011 00110

000 11110

ПО 00110

111 10101

Добавить проверки для образования кода с обнаружением пакетов ошибок из

слов длиной 1 байт.

2.7. Буквенно-цифровые коды — взвешенные коды

Рассматривавшиеся до сих пор коды предполагали наличие

простого белого шума. Такое предположение хорошо описывает

канал в 'машинах многих типов, однако в некоторых системах вы-

падения (или вставки) символов при последовательной передаче

не обнаруживаются этими кодами, что приводит к нарушению

синхронизации.

Человеку свойственно делать ошибки другого рода. Типичным

примером ошибок человека является перестановка соседних цифр

при записи чисел: например, 67 превращается в 76. Другой стан-

дартной ошибкой может быть дублирование неправильной цифры

в трехзначном числе, в котором две соседние цифры совпадают:

например, 667 превращается в 677. Здесь происходит простая за-

мена одной цифры. Таковы две наиболее распространенные ошиб-

ки человека при записи чисел. В система^ содержащих как бук-

вы, так и цифры, очень часто путаются цифра «нуль» и буква

Достаточно часто встречаются ситуации, в которых полный

набор используемых символов состоит из букв, пробела и <10 де-

сятичных цифр. Таким образом, исходный алфавит содержит 26+

+ 1 + 10 = 37 символов. К счастью, 37 — 'простое число, что позво-

ляет применять следующий метод проверки. Символы сообщения

снабжаются весами 1, 2, 3, ..., начиная с проверочного символа

сообщения. Затем производится редукция суммы по модулю 37

(т. е. берется остаток от деления суммы на 37) так, что провероч-

ный символ может быть выбран таким образом, чтобы вся сумма

была сравнима с 0 по модулю 37. Заметим, что пробел, стоящий

в конце в качестве проверочного символа — это не то же самое,

что отсутствие символа.

Легко проверить, что любая перестановка двух соседних цифр

обнаруживается так же, как и дублирование неверной цифры

(что эквивалентно замене одного символа). Можно обнаружить

также много других изменений. Перестановка нуля и буквы О

также является заменой одного символа. Рассматриваемый код

очень полезен в процессах, предусматривающих участие человека.

Заметим, что длина сообщения не фиксирована и при необходи-

мости может превышать 37 символов (хотя при этом нужны спе-

циальные предосторожности). Такое кодирование можно исполь-

зовать в кредитных карточках, в списках для записи некоторых

названий и т. д. Вероятность того, что случайная последователь-

ность удовлетворяет такой проверке, равна 1/37. Таким образом,

используя эту простую проверку на четность, можно выявить око-

ло 97% случаев подлога.

Для того чтобы найти взвешенную сумму наиболее простым

способом, заметим, что при вычислении частичных сумм множест-

ва п чисел и окончательном их суммировании получаем, что пер-

вое число входит в окончательную сумму п раз, второе —

п—1 раз, следующее п—2 раза и т. д. Последнее число войдет в

сумму один раз. Таким образом, имеем требуемую взвешенную

сумму чисел, соответствующую используемым в сообщении симво-

лам алфавита.

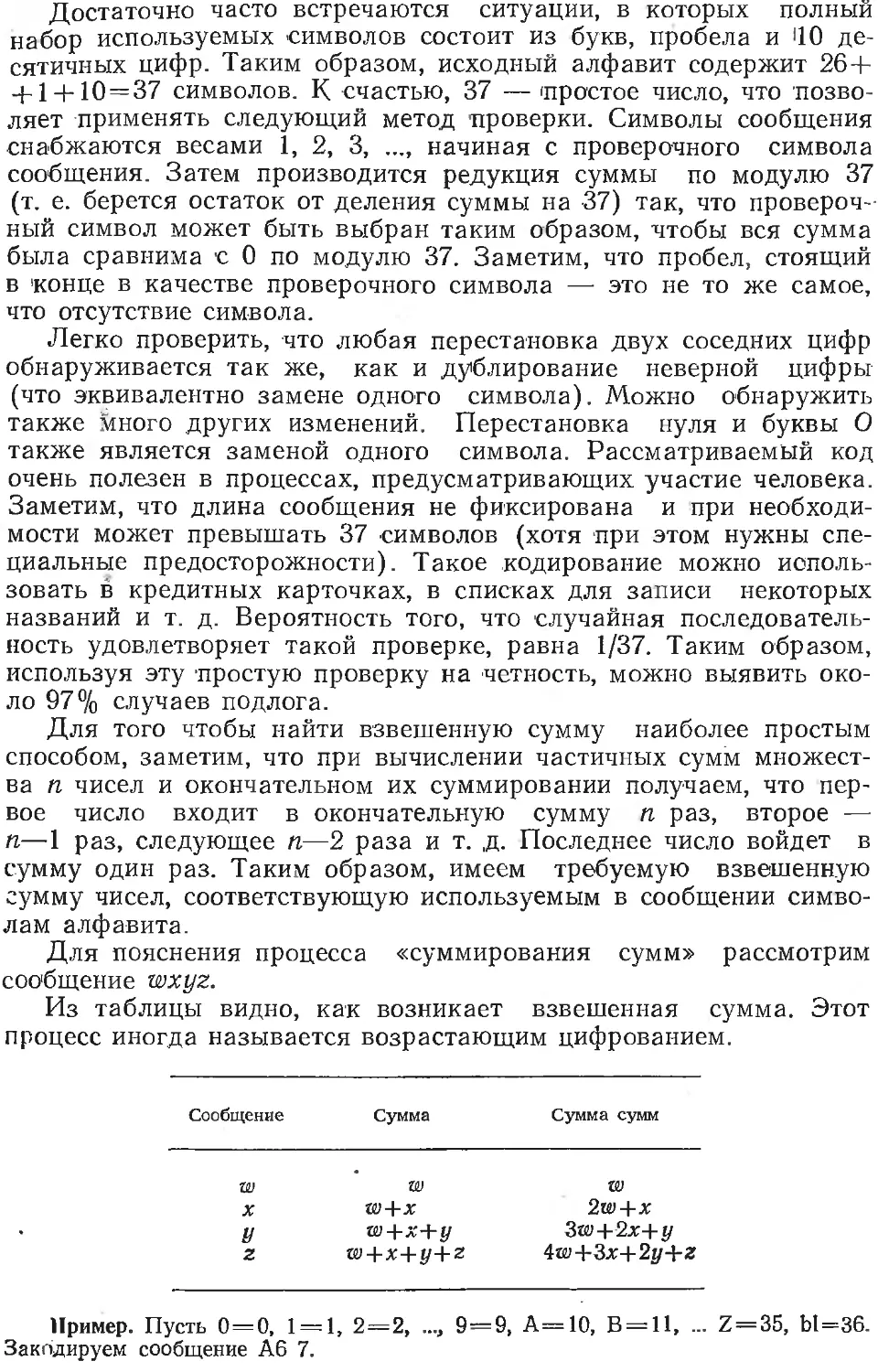

Для пояснения процесса «суммирования сумм» рассмотрим

сообщение wxyz.

Из таблицы видно, как возникает взвешенная сумма. Этот

процесс иногда называется возрастающим цифрованием.

Сообщение Сумма Сумма сумм

W W W

X w + x 2w+x

У w+x-Yy 3w+2x+y

Z W+x+y+Z 4w+3x+2y+z

Пример. Пусть 0=0, 1 = 1, 2=2, ..., 9=9, А=10, В = 11, ... Z = 35, Ы=36.

Закодируем сообщение А6 7.

Следует поступить так:

Сумма Сумма сумм

А= 10 10 10

6 = 6 16 26

Ы = 36 52 78

7 = 7 59 137

X = X 59 + х 196+ х

196+ х | 37

185 5

11 +х

Поскольку 11+лг должно делиться на 37, получаем x=26=Q. Закодиро-

ванное сообщение имеет вид А6 7Q. Для того чтобы на приемном конце про-

верить правильность полученного сообщения, следует поступить так: <

А 6 Ы 7 Q 10X5=50 6X4=24 36X6=108 7X2=14 26X1=26 Сумма =1222=37X6 = 0 по модулю 37

Задачи

2.7.1. Пусть 0=0, 1 = 1, ..., 9=9, А=10, В=11, ..., Z=35, Ы=36. Закоди-

руйте B23F mod 37. Ответ: B23F9.

2.7.2. Является ли К9К9 правильным сообщением в коде из задачи 2.7.1?

2.8. Обзор модулярной арифметики

Поскольку проверки на четность используются в дальнейшем

довольно часто, следует иметь ясное представление об арифмети-

ке, лежащей в основе соответствующих преобразований. Как было

показано, сложение по модулю 2 является той арифметической

операцией, которая применяется в простых проверках на четность,

и оно совпадает с логическим сложением (исключающее ИЛИ).

Правила сложения таковы:

0 + 0 = 0

0+1 = 1

1+0=1

1 + 1 = 1

поСистеме нет других чисел, отличных от 0 и 1. Если действовать

на оРавилам обычной арифметики, то нужно разделить результат

и взять остаток. Когда позже будет рассматриваться алгеб-

ра линейных уравнений и многочленов с коэ фициентами, являю,

щимися числами в системе счисления ио модулю 2, то для сложе.

ния 'будет использоваться та же таблица. При умножении приме-

няются следующие правила:

0x0 = 0

0x1=0

1X0=0

1X1 = 1

Таким образом, умножение совпадает с логическим И.

Иногда 'будут применяться вычеты по модулю, отличному от 2.

Например, в предыдущем разделе использовались вычеты по мо-

дулю 37. В общих чертах теория для любого простого основания

р (например, 37) очень похожа на теорию для основания 2, так

что подробности здесь можно опустить. Для понимания соответ-

ствующей арифметики и алгебры следует лишь внимательно про-

честь начало этого раздела и внести небольшие изменения. При

сложении и вычитании по модулю р следует разделить каждое

число на р и взять положительный остаток.

При умножении по модулю т (когда т не простое число) сле-

дует быть более осторожным. Предположим, что числа а и Ь

сравнимы с числами’^' и Ь' по модулю т. Это означает, что а=

= а'тоАт, b=b'modm или a = a'+klm, b = b'+k2m для некоторых

целых чисел k и k'. Для 'произведения ab имеем ab=a'b'+

+ a'k2m +-b'kvm + kyk2m2, ab == a'b' mod m.

Рассмотрим теперь частный случай: tz=15, 6=12, m=10. Име-

ем a'=5, b' = 2 и fi^a'fc'sOmod 10. Но ни а, ни b не равны 0!

Важное свойство умножения, состоящее в том, что если произве-

дение равно 0, то по крайней мере один из сомножителей ра-

вен 0, выполнение только для простых оснований. Именно это оп-

ределяет важность простых оснований. Теперь видно, почему чис-

ло 37 было столь удобным в разд. 2.7. Читатель должен хорошо

разобраться в модулярной арифметике, особенно для простого

основания, поскольку в гл. 11 появится более сложная задача по-

строения соответствующей модулярной алгебры. Поэтому в сле-

дующем разделе дается еще один пример кодирования такого

типа.

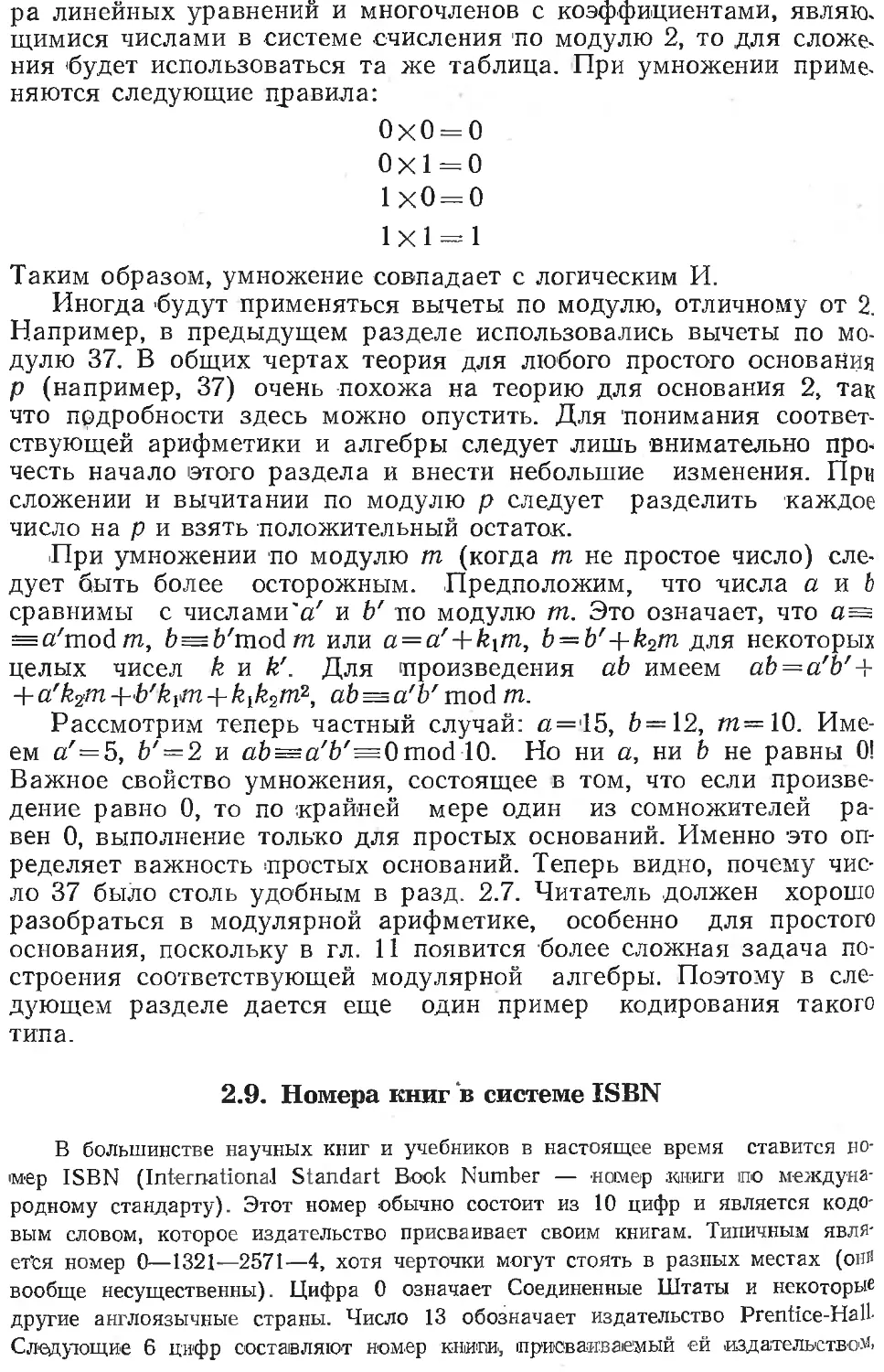

2.9. Номера книг в системе ISBN

В большинстве научных книг и учебников в настоящее время ставится но-

мер ISBN (International Standart Book Number — номер книги ио междуна-

родному стандарту). Этот номер обычно состоит из 10 цифр и является кодо-

вым словом, которое издательство присваивает своим книгам. Типичным явля-

ется номер 0—1321—2571—4, хотя черточки могут стоять в разных местах (он"

вообще несущественны). Цифра 0 означает Соединенные Штаты и некоторые

другие англоязычные страны. Число 13 обозначает издательство Prentice-Hall-

Следующие 6 цифр составляют иом-ер книг®, присваиваемый ей издательство^

последняя цифра является взвешенной суммой, как в разд. 2.6. Арифметика

по модулю 10 непригодна, поскольку 10 — составное число. Поэтому использует-

ся проверочная сумма по модулю И, и если проверочная цифра равна 10, вы-

бирается символ X.

Среди своих книг автор нашел номер 0—1315—2447—X. Для проверки

правильности этого номера в системе ISBN поступаем следующим образом:

0

1 1 1

3 4 5

1 5 10

5 10 20

2 12 32

4 16 48

4 20 68

7 27 95

Х= 10 37 132 = (11)Х(12)=0 mod П

Все в порядке!

Здесь мы снова встречаемся с простым кодом с обнаруживанием ошибок,

предназначенным скорее для людей, а не ЭВМ. Ясно, что такие коды широко

распространены.

Задачи

2.9.1. Проверьте ISBN 0—13165332—6.

2.9.2. Проверьте ISBN 0—1391—4101—4.

2.9.3. Имеет ли смысл ISBN 07-—028761—-4?

2.9.4. Проверьте ISBN ваших книг.

Глава 3

Коды с исправлением ошибок

3.1. Необходимость в исправлении ошибок

Часто простой метод обнаружения ошибок с последующим по-

вторением передачи является недостаточным. Немедленно возни-

кает следующий вопрос: «Если ЭВМ может обнаружить ошибку,

почему бы ей не найти, где она произошла?» И, действительно,

при подходящем кодировании это можно сделать. Можно, напри-

мер, повторять каждый символ или каждое вычисление три раза,

и затем производить голосование. Однако, как будет показано, су-

ществуют -лучшие методы. В качестве примера, когда необходимо

использовать код с исправлением ошибок, можно указать переда-

чу информации с Марса на Землю. При этом время передачи на-

столько велико, что- к моменту обнаружения ошибки исходное со-

о Щение уже может быть стертым. В настоящее время (1979 г.)

этой системе передачи используется код, который может исправ-

ЯТв Д° Восьми ошибок в одном блоке цифр.

спРавление ошибок очень полезно также в типичных запоми-

Щих устройствах. Например, американское Бюро переписи на-

селения хранит большую часть имеющейся у него информации

на магнитных лентах. С течением времени качество записей су.

шественно ухудшается и наступает момент, когда некоторые из

них не могут 'быть надежно считаны. При этом первоначальный

источник информации часто оказывается уже недоступным, и по-

этому записанная на ленте информация теряется навсегда. Если

при кодировании информации предусмотрена возможность исправ-

лять ошибки, то соответствующие типы ошибок могут быть ис-

правлены.

Исправление ошибок можно производить на аппаратурном

уровне. Например, в ЭВМ NORC имелось устройство для просто-

го исправления изолированных ошибок, возникающих в запоми-

нающих устройствах на электронно-лучевых трубках. Часто ис-

правление ошибок производится только в запоминающих устрой-

ствах. ЭВМ STRETCH, построенная фирмой IBM для «более де-

тального изучения состояния дел», предусматривает исправление

одиночных ошибок и обнаружение двойных ошибок (см. разд. 3.7)

в большинстве своих устройств. На приемных испытаниях ЭВМ

STRETCH утверждалось, что в одной из .цепей в первые минуты

работы возникла ошибка, но схемы исправления ошибок ликвиди-

ровали ее и обеспечили правильную работу ЭВМ в течение часа.

Среди'имеющихся в настоящее время (1979 г.) ЭВМ система «Эк-

липс» обеспечивает аппаратурное исправление некоторых ошибок.

ЭВМ CRAY 1 предусматривает исправление ошибок в качестве до-

полнительной возможности запоминающих устройств. Проверка

на аппаратурном уровне описана в [15].

Исправление ошибок может осуществляться также на програм-

мном уровне, как это делает, например, американское Бюро пере-

писи населения при записи информации на магнитную ленту. Ра-

нее уже упоминалось о методах обнаружения ошибок при записи

на магнитный барабан на программном уровне. При этом также

можно использовать иоправление ошибок. Во многих случаях ко?

ды с исправлением ошибок предусмотрены в программном обеспе-

чении. Программный подход удобнее тем, что он позволяет ис-

правлять ошибки в более ответственных массивах информации и

пропускать менее ответственные. Более того, недостатки вычисли-

тельных систем выявляются только в процессе накопления опыта,

и только тогда становится ясным, где и какая нужна защита от

ошибок. Только после того, как моделирование защиты от ошибок

на программном уровне докажет свою способность справиться с

недостатками, защиту можно добавлять к системе на аппаратур-

ном уровне.

3.2. Прямоугольные коды

Первыми и наиболее простыми кодами с исправлением оши-

бок являются коды с утроением, в которых каждое передаваемое

сообщение повторяется три раза, а на приемном конце произво-

дится голосование по большинству. Ясно, что такая система ис-

правляет любые одиночные ошибки. Однако не менее ясно, что

такая система кодирования очень неэффективна. Три параллель-

ных ЭВМ вместе с устройством сравнения и прерывания при TJ“-

обходимости оказываются слишком дорогими. .Поэтому нужно

кать лучшие методы кодирования информации, позволяющие ис-

правлять одну ошибку.

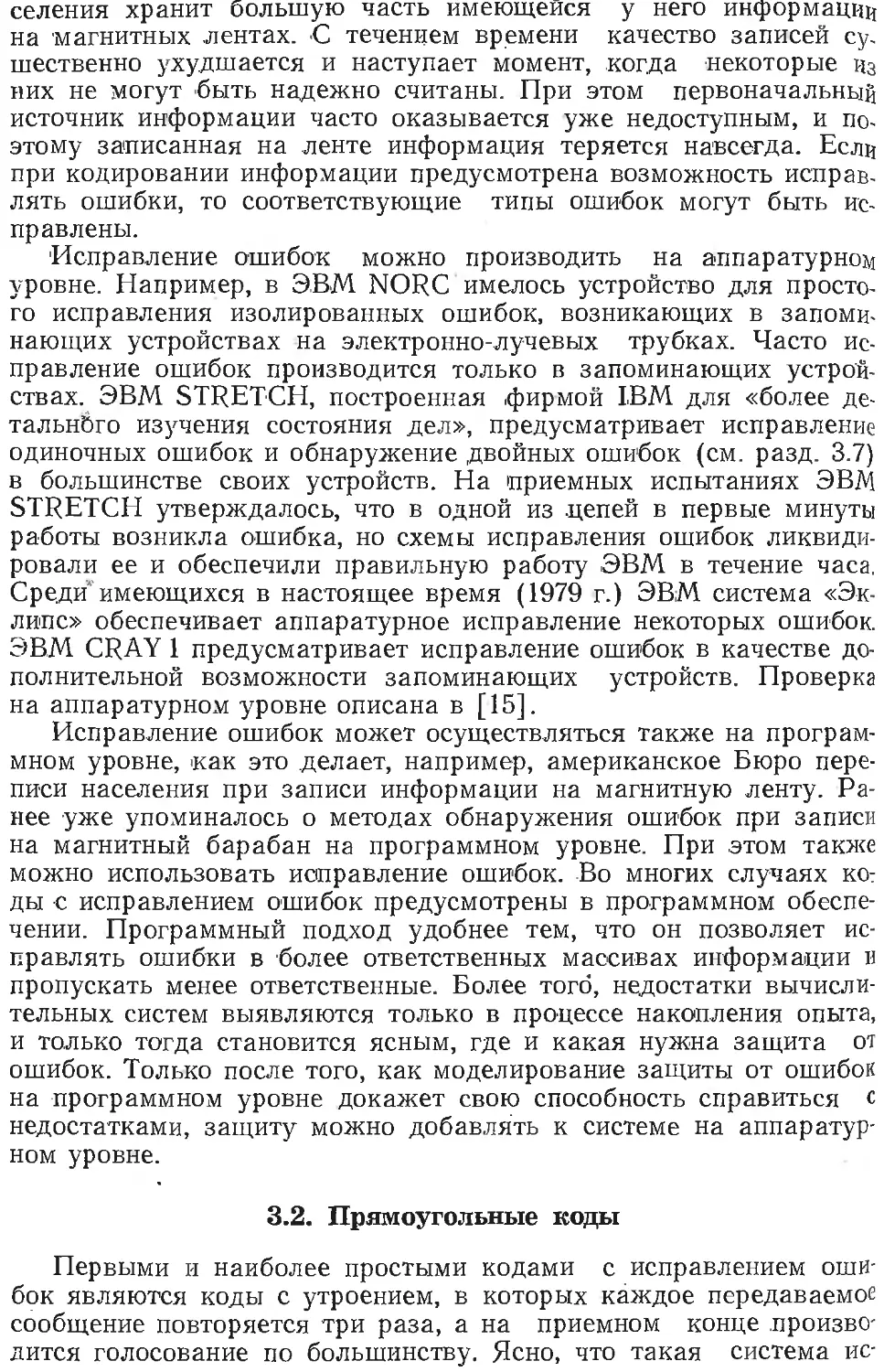

Следующими по простоте кодами с исправлением ошибок

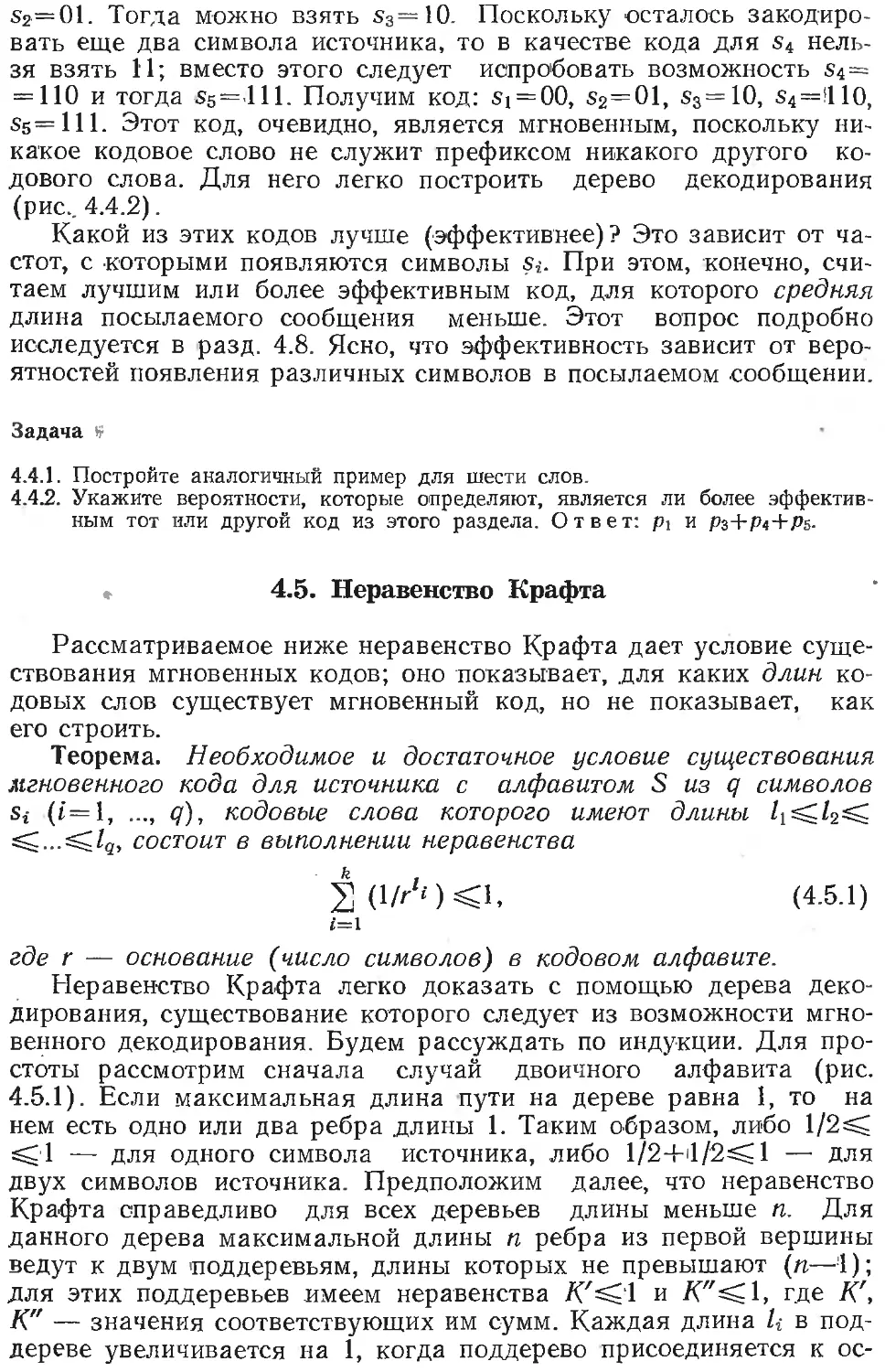

ляются прямоугольные коды, в которых сообщение представляет-

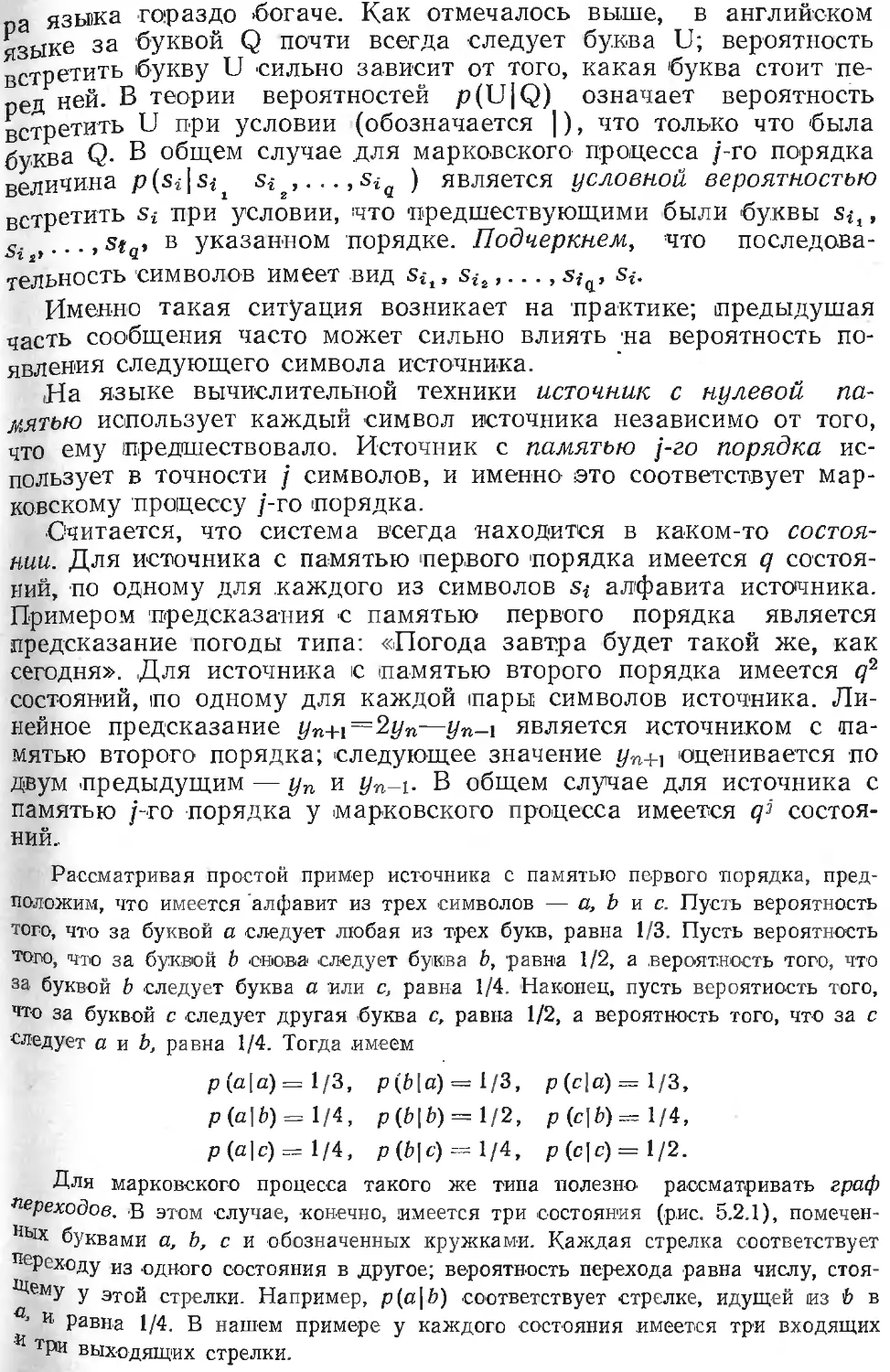

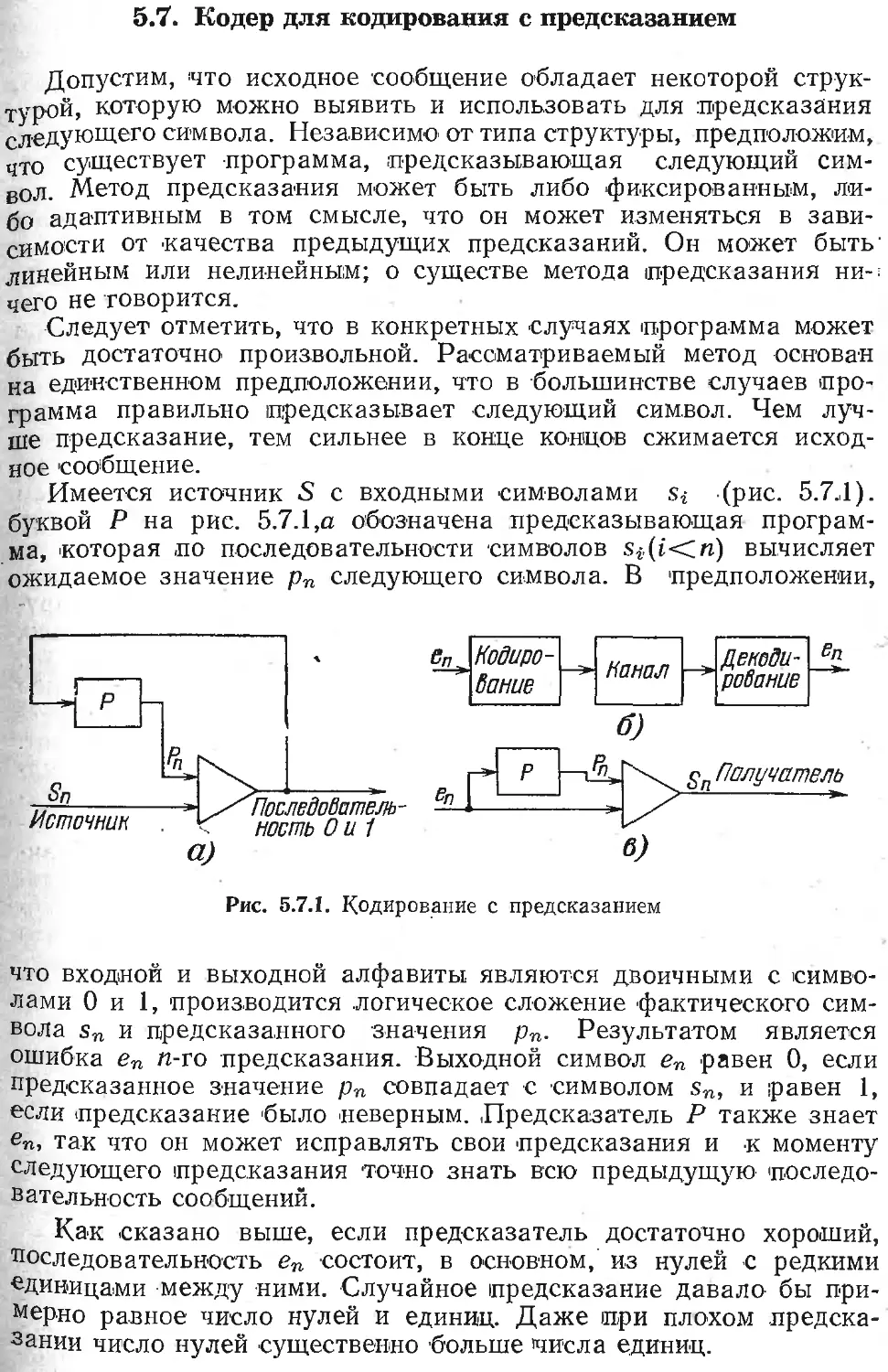

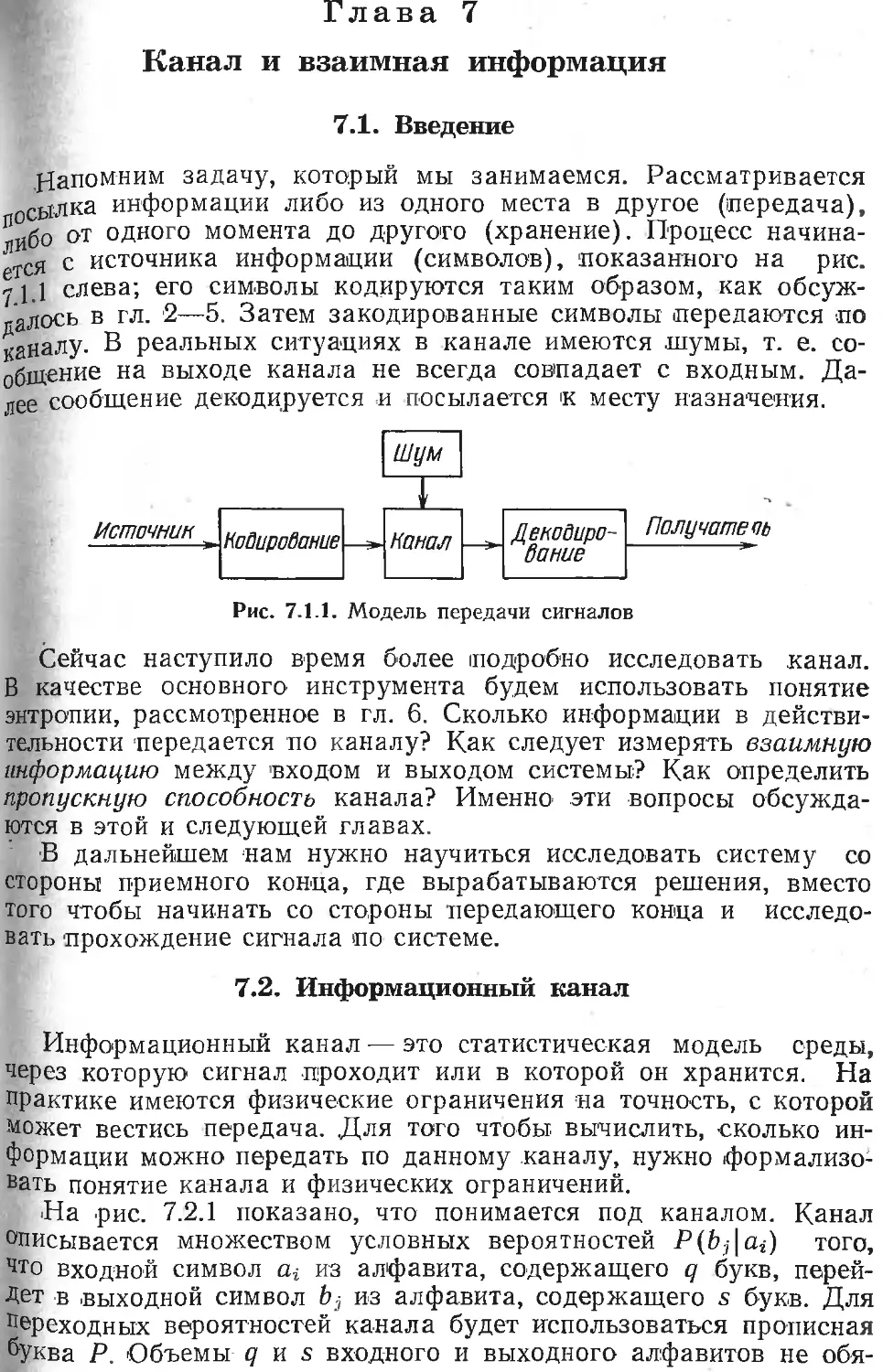

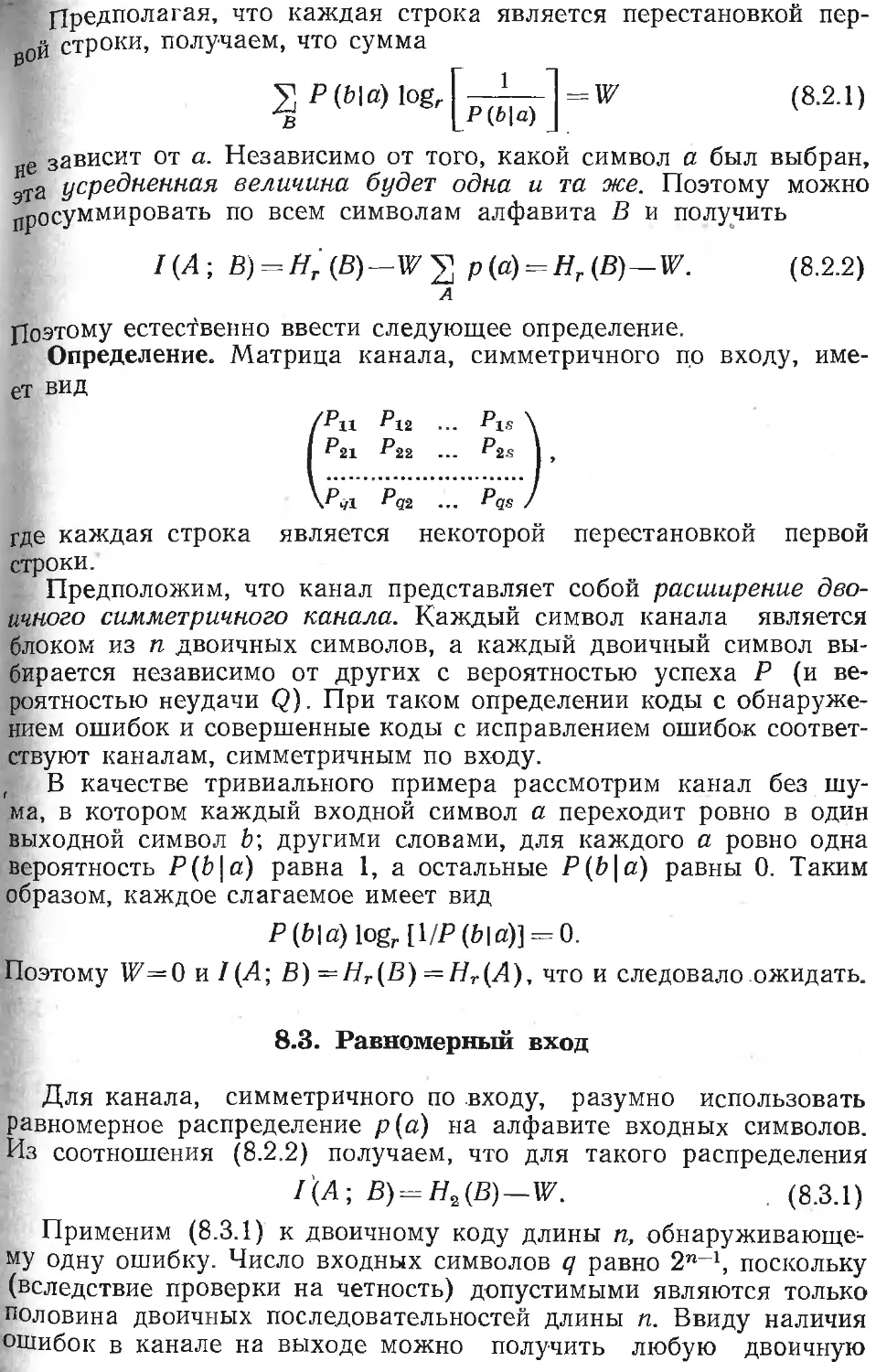

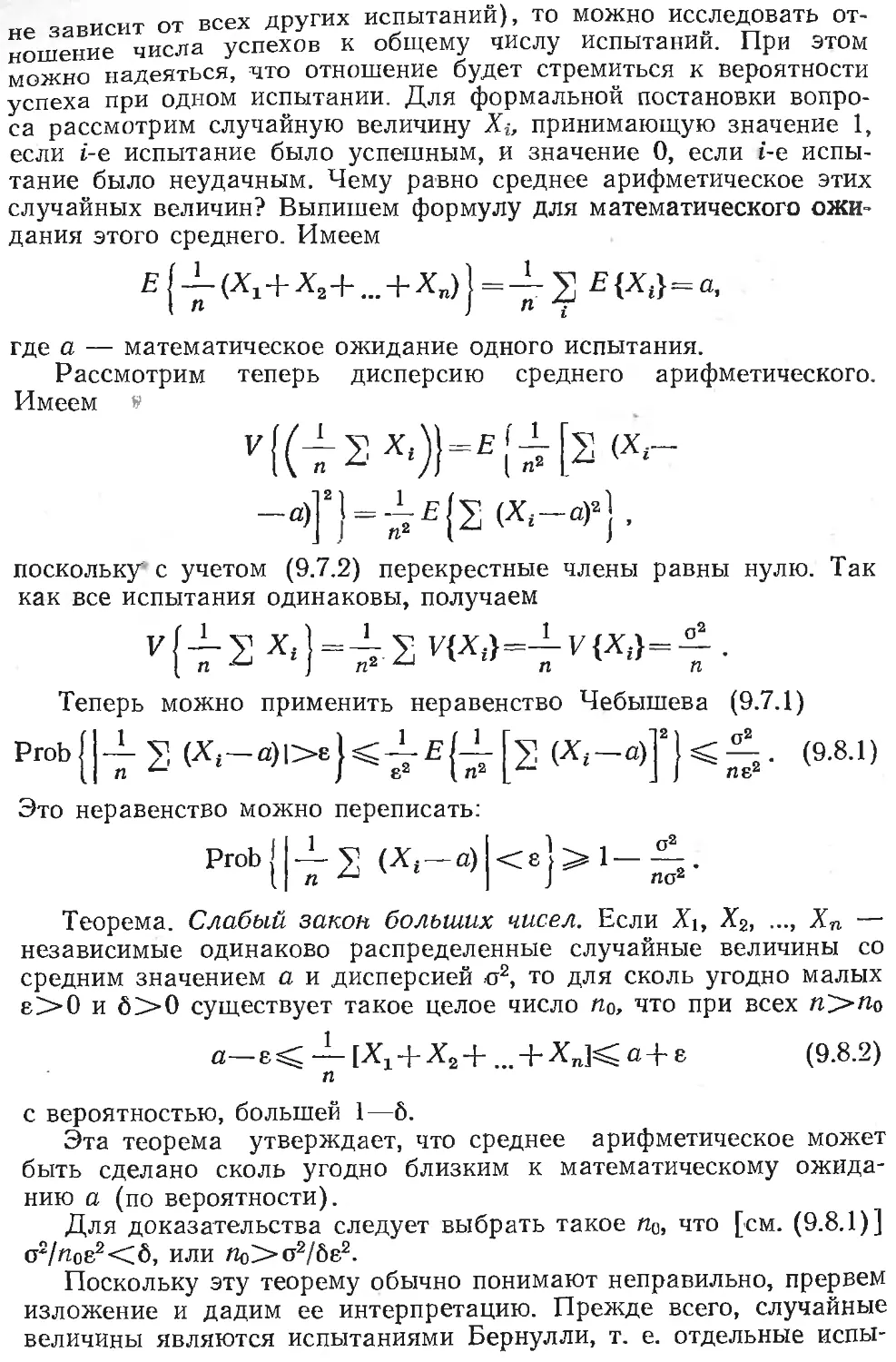

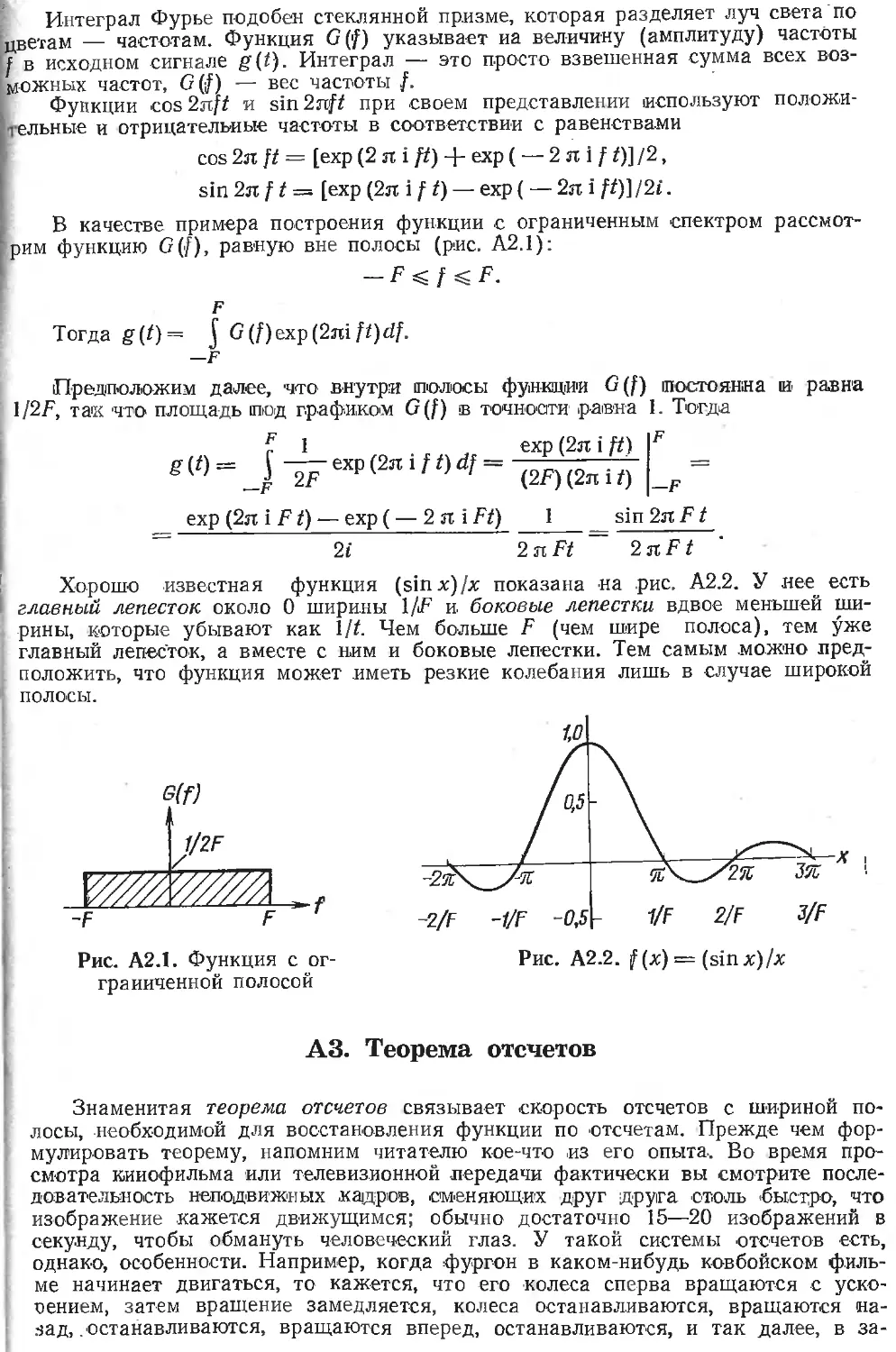

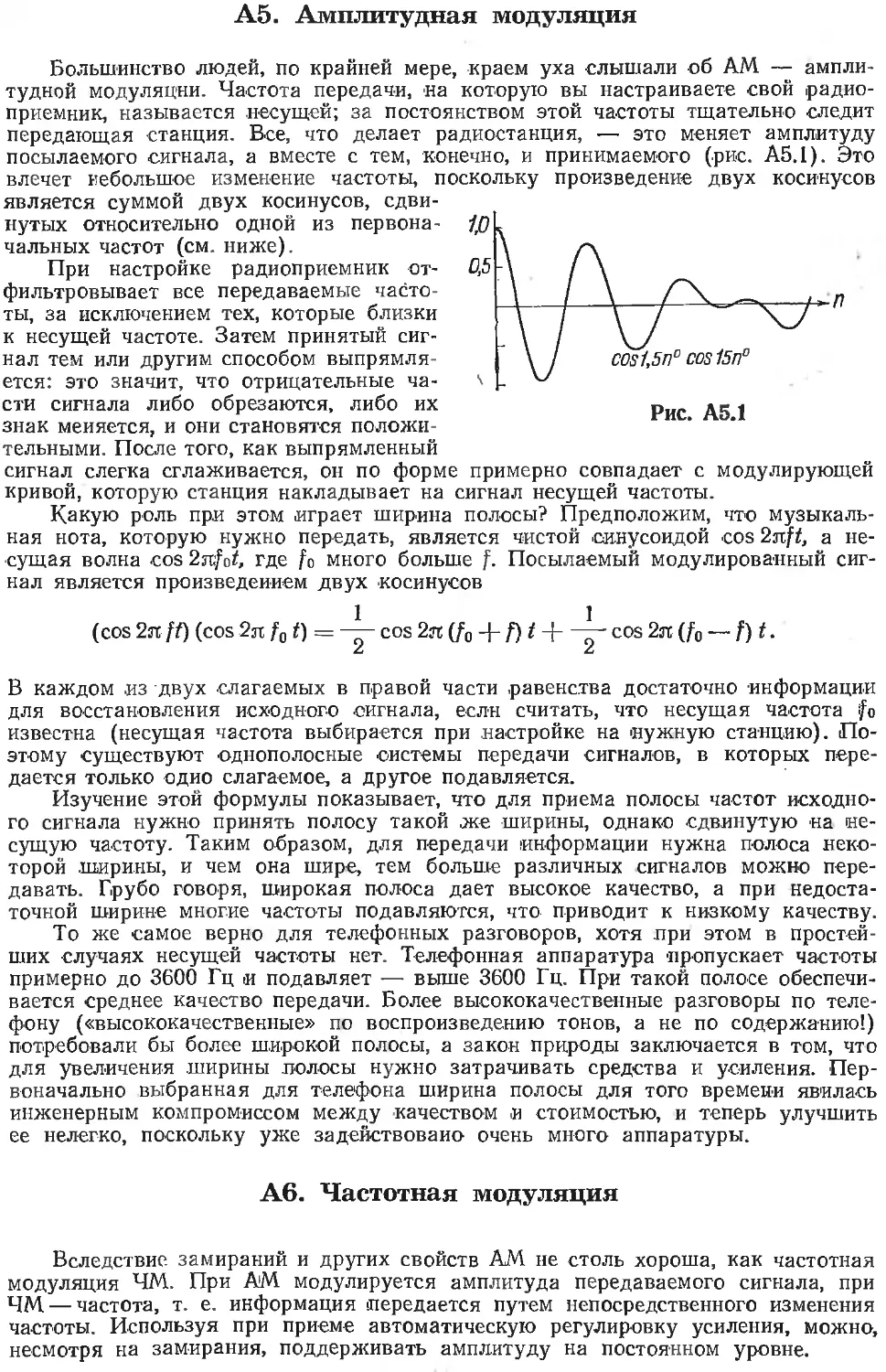

ся в прямоугольниках размером (т—il)X(n—1) (рис. 3.2.1), хотя

фактически сообщение не обязано иметь такой вид. Затем к каж-

дой строке, состоящей из т—1 символов, добавляется проверка

'на четность, так что длина строки становится

равной т символам. Аналогично, к каждому

|столбпу добавляется по одному проверочному

[символу. При этом несущественно, заполняет-

ся или нет правый нижний угол. Проверочный

символ выбирается так, чтобы общая сумма

|была четной, тогда четность последней строки

(равна четности крайнего правого столбца. Та-

ким образом, первоначальный прямоугольник

из (т—1)(и—1.) двоичных символов превра-

щается в массив из тп двоичных символов.

Поэтому избыточность равна 1 + 1/(т—1)+.

+ 11 (п—1) + 1/(т—1) (п—1). При заданном

не-

ис-

яв-

п-

Рис.

о

о

о

о

т-1

о о • •

о • •

о • •

о

о

о

о X

о х

о х

о

X

X X

Прямо-

коды:

о

X X

3.2.1.

угольные

О — позиции сообщений;

X — проверочные пози-

ции

тп избыточность тем меньше, чем ближе прямоугольник к квадра-

ту. Для квадратных кодов размера п имеется (п—I)2 информаци-

онных символов и (2п—1) проверочных символов вдоль сторон.

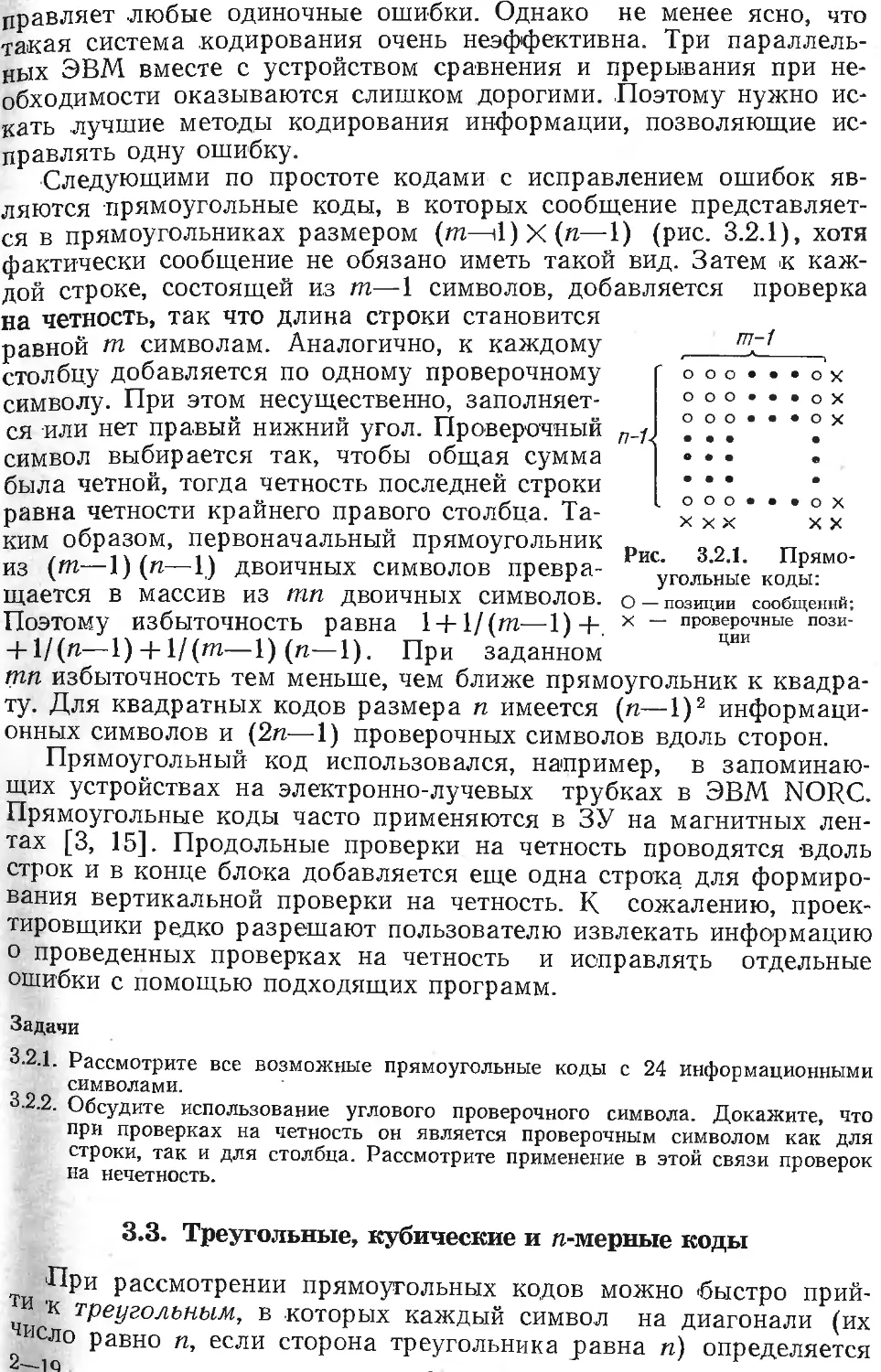

Прямоугольный код использовался, например, в запоминаю-

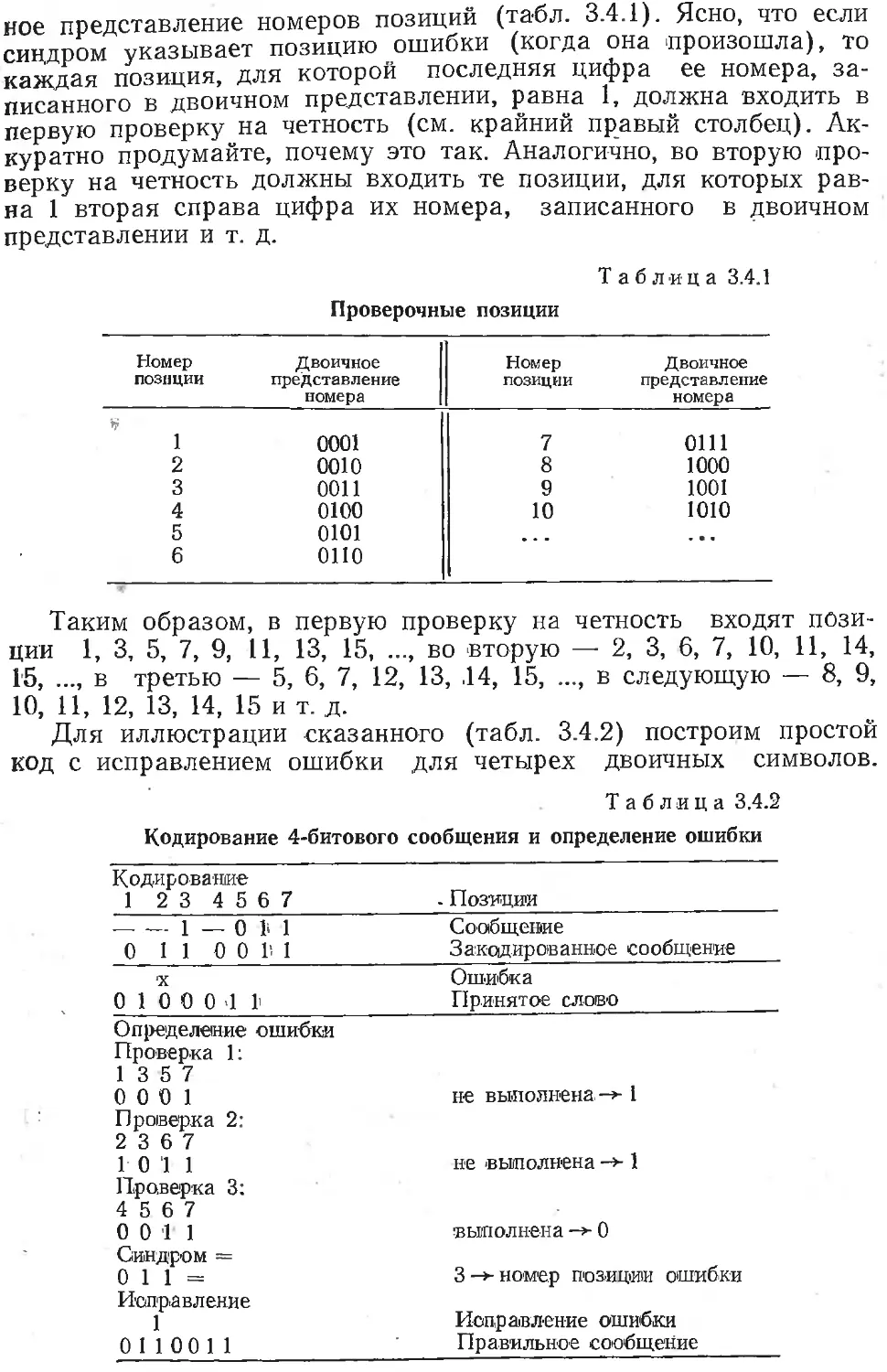

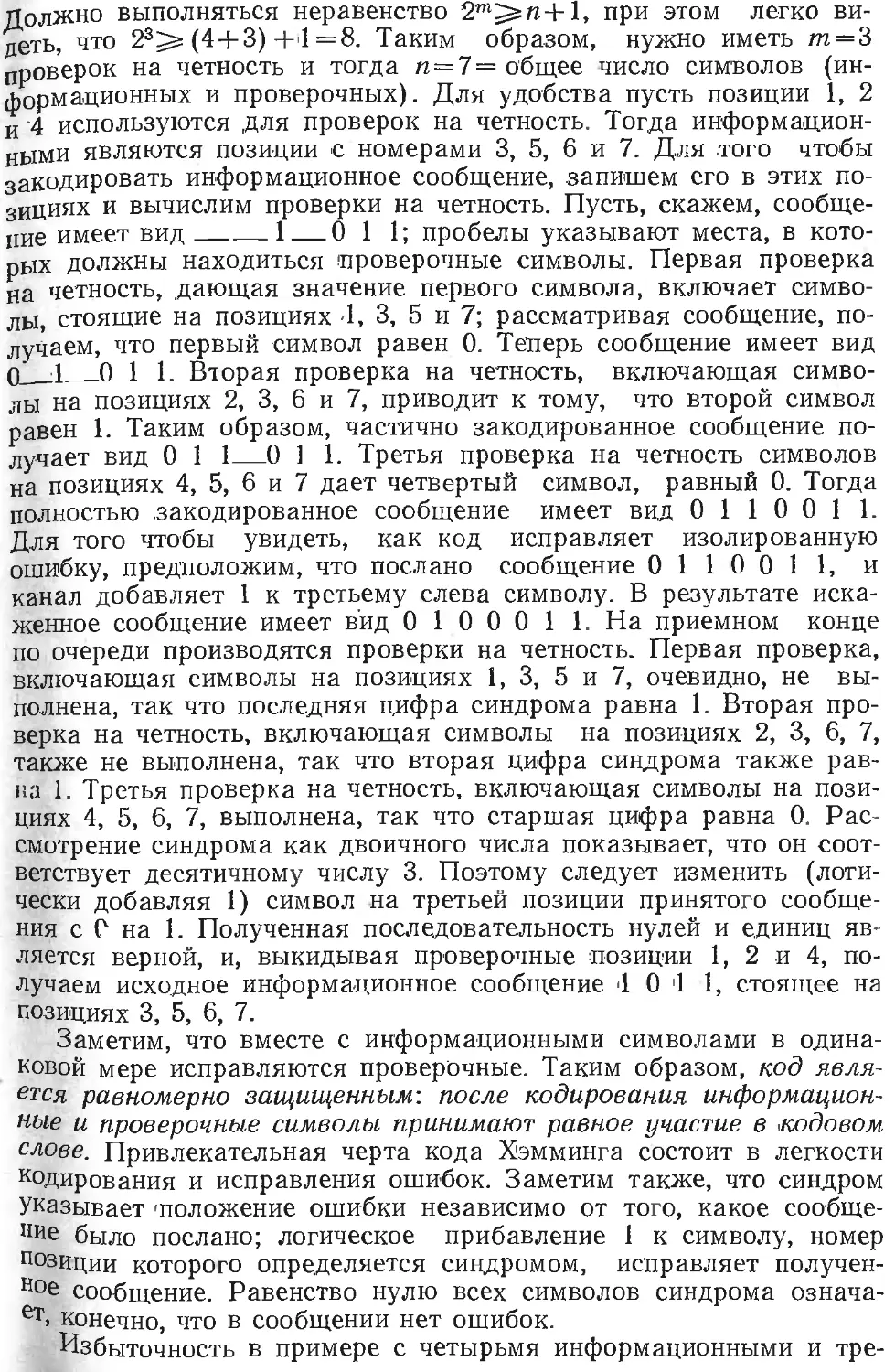

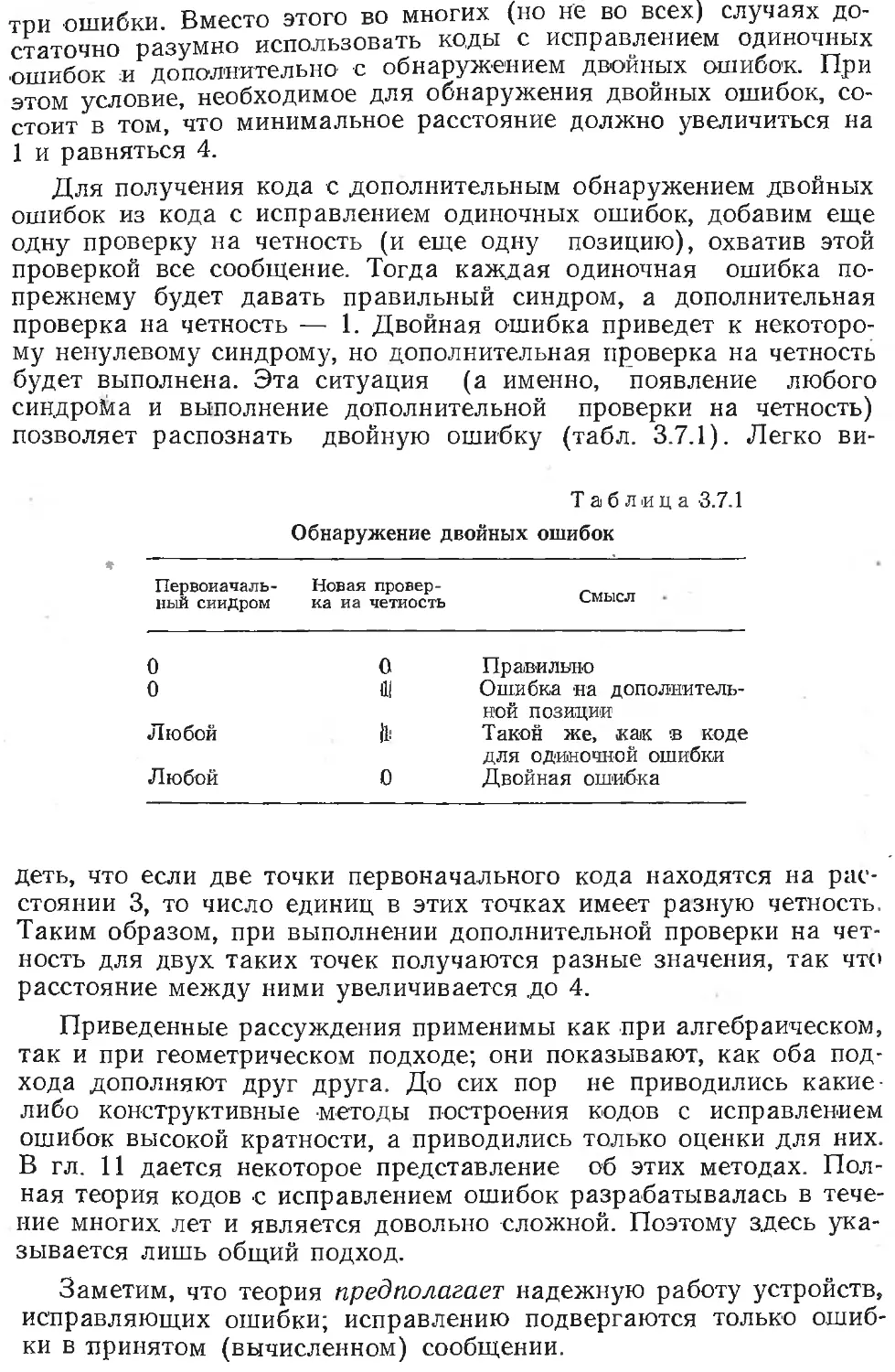

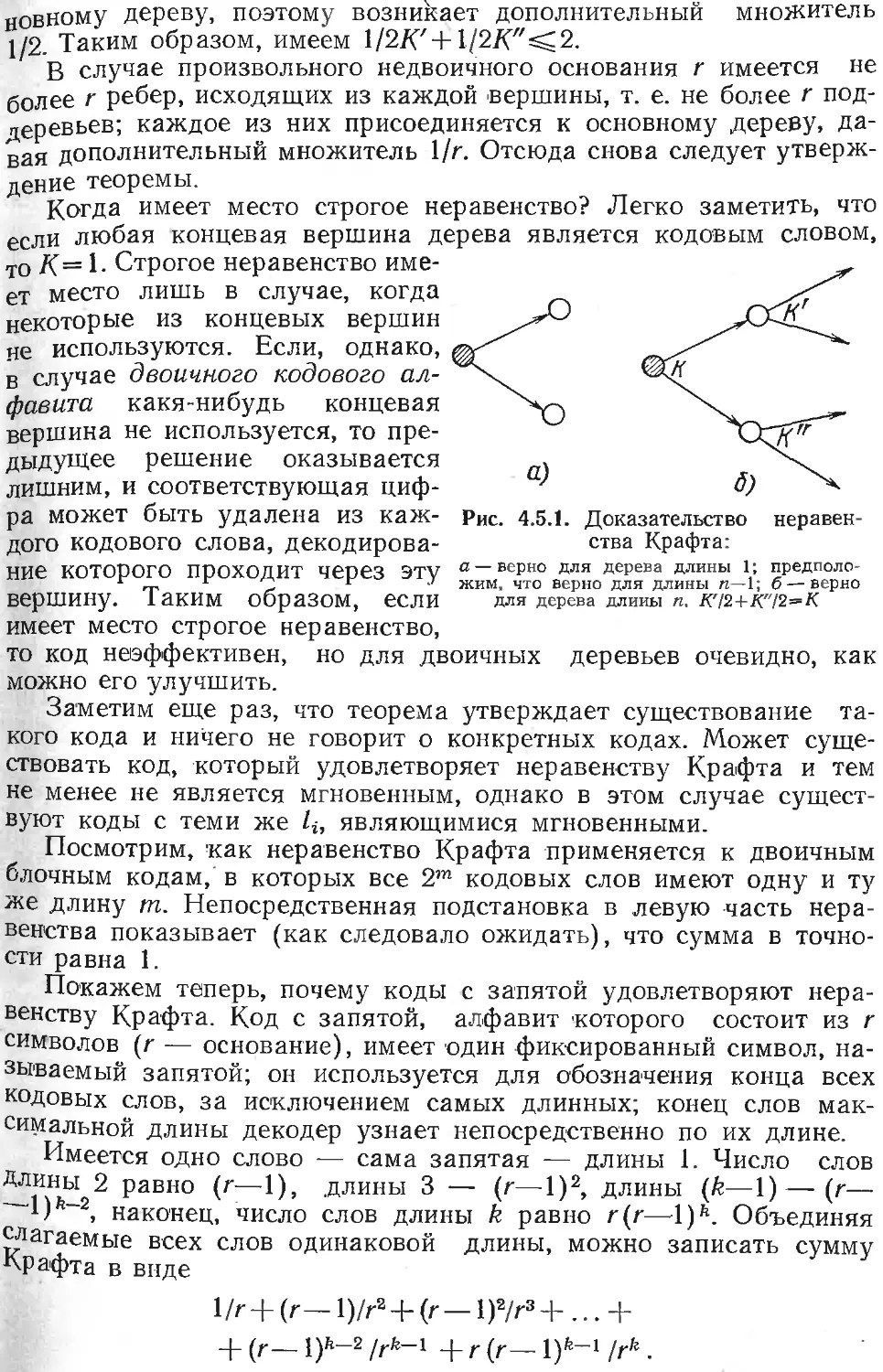

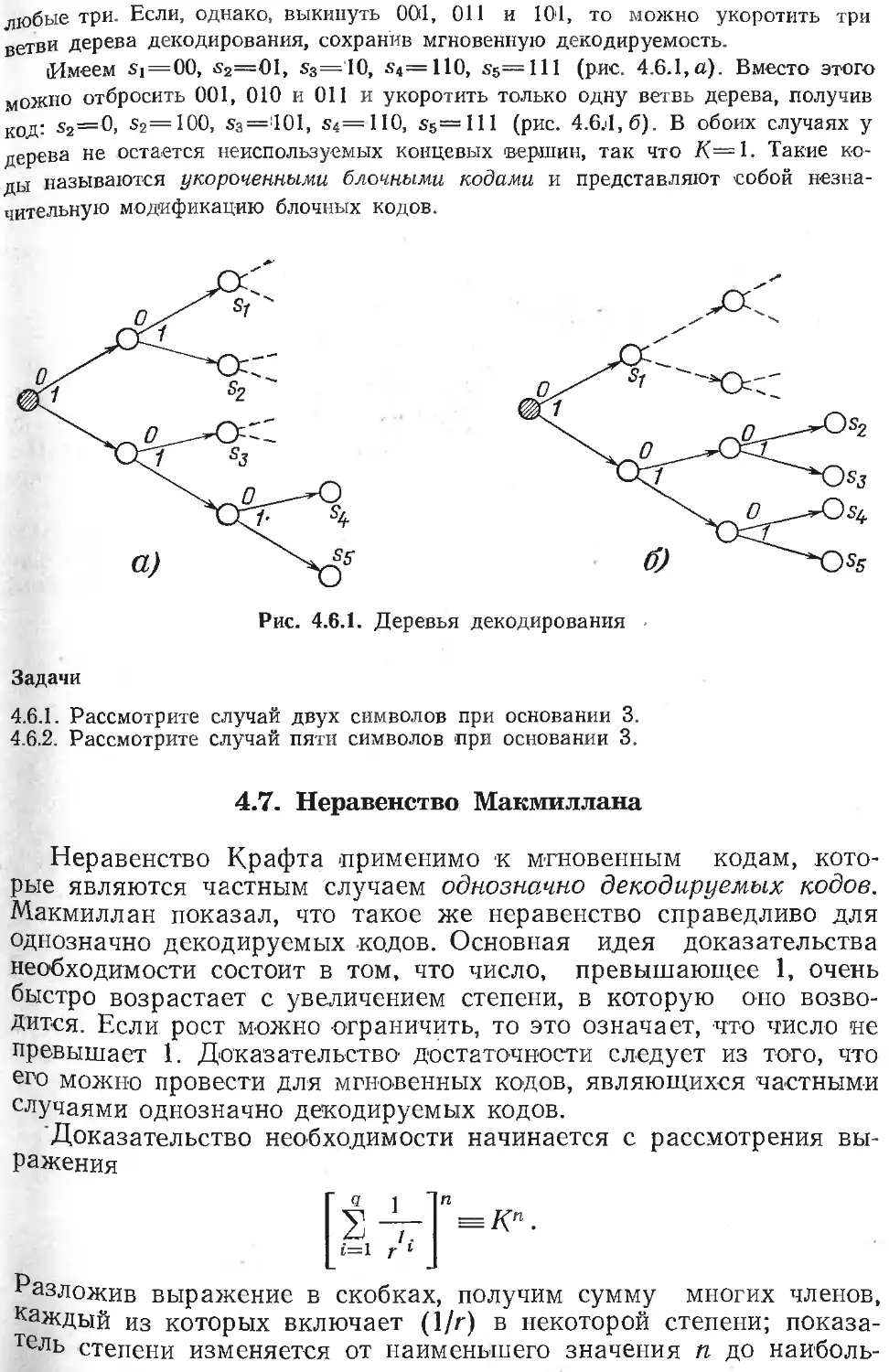

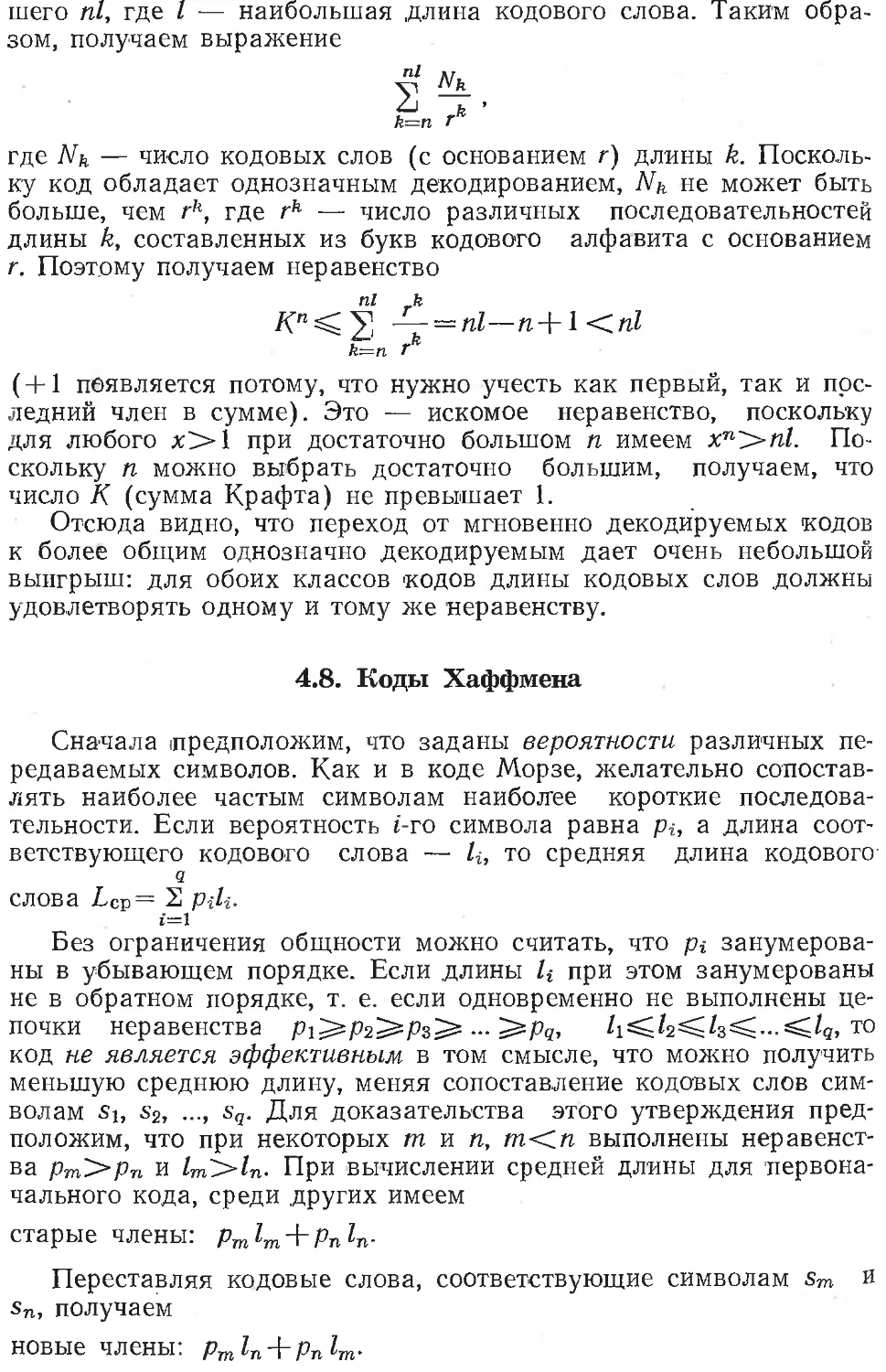

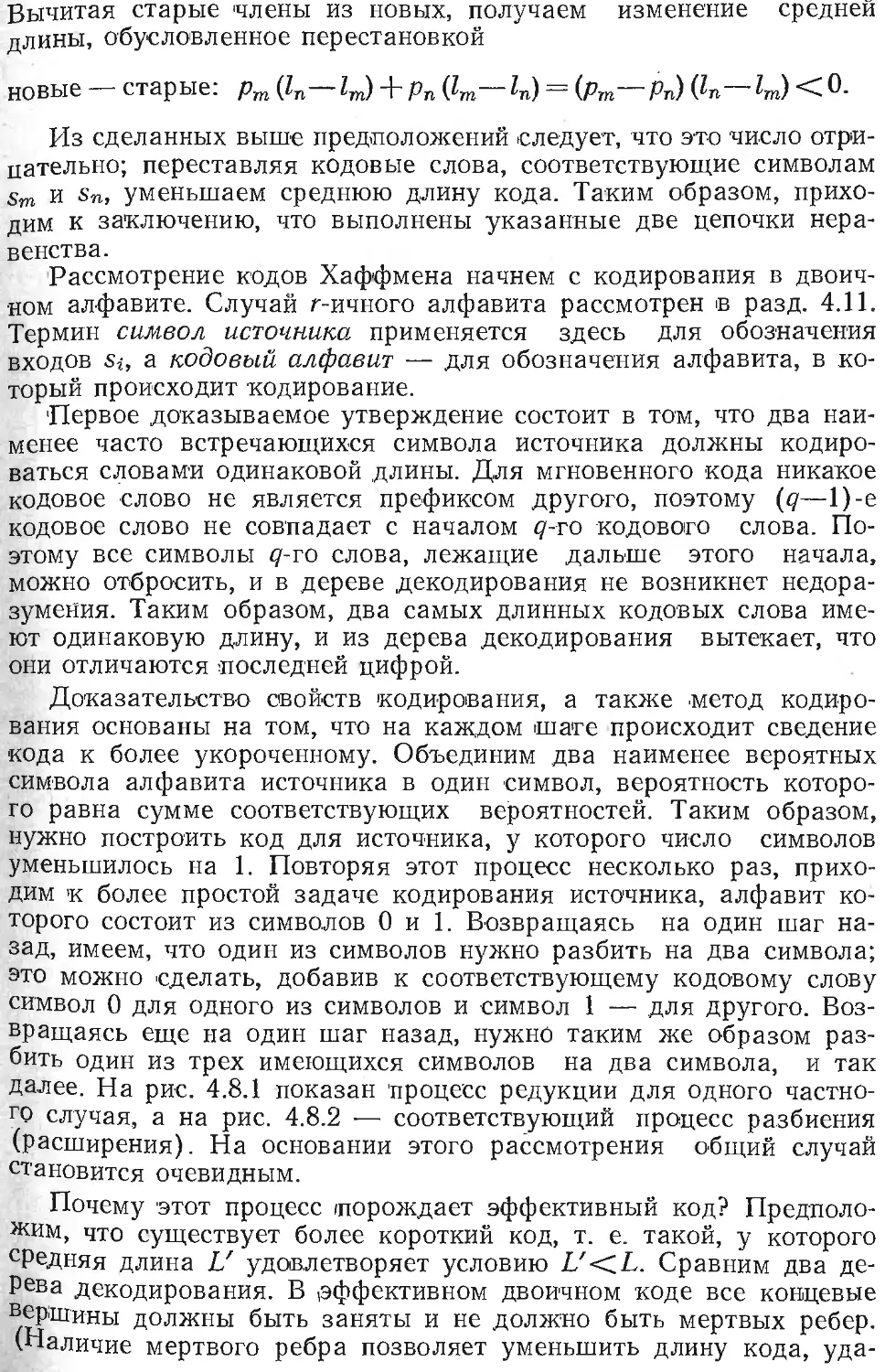

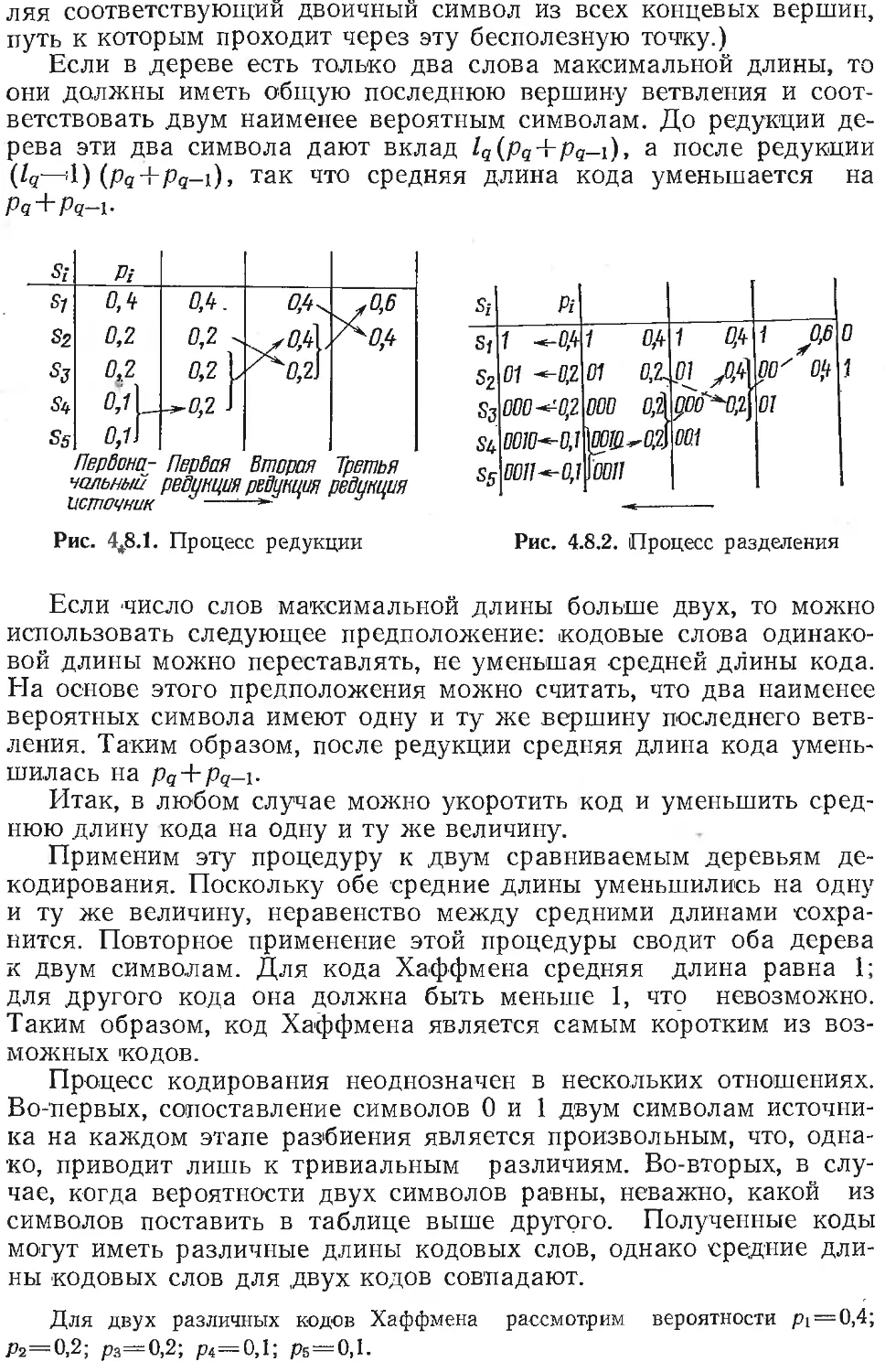

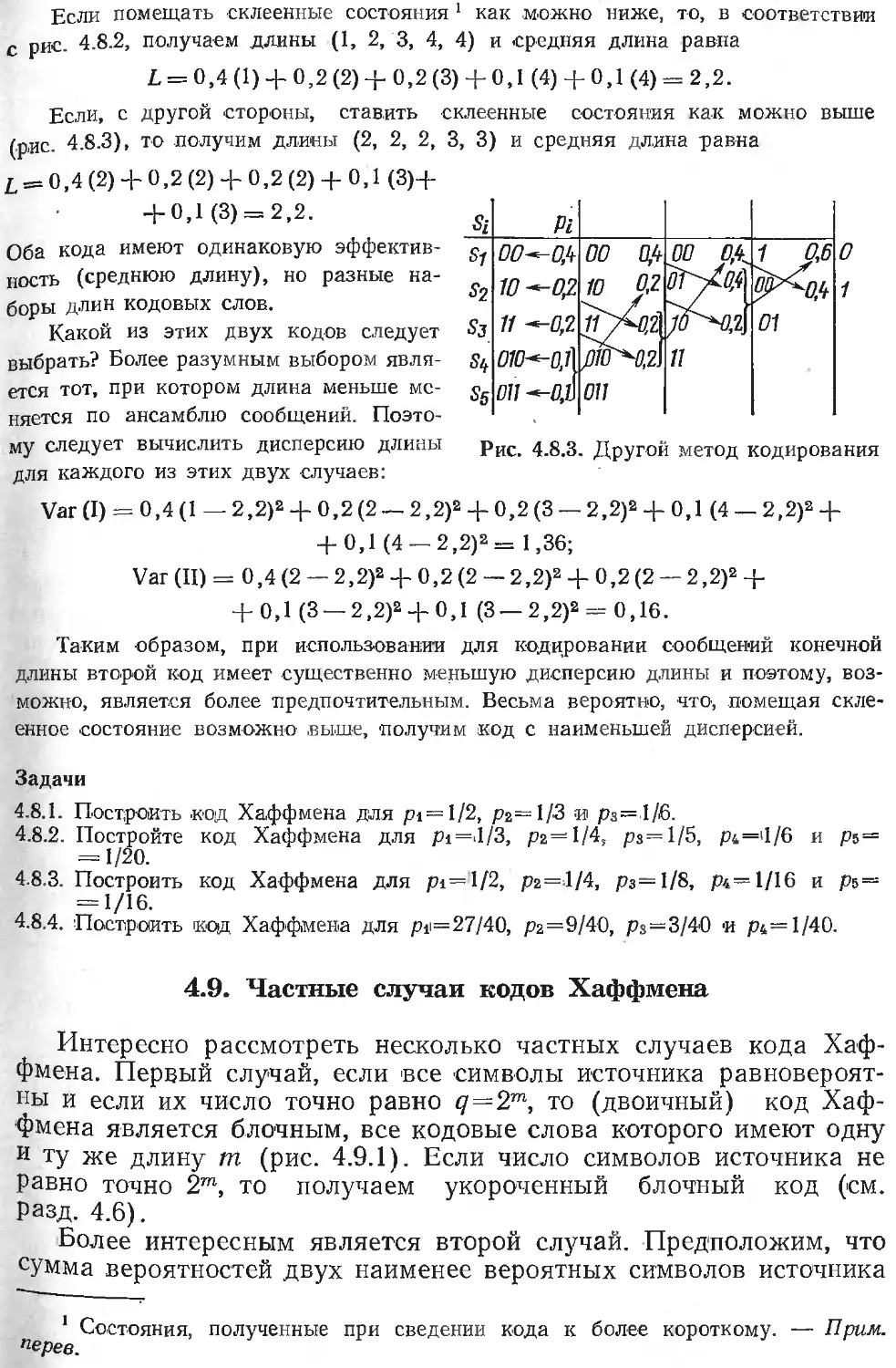

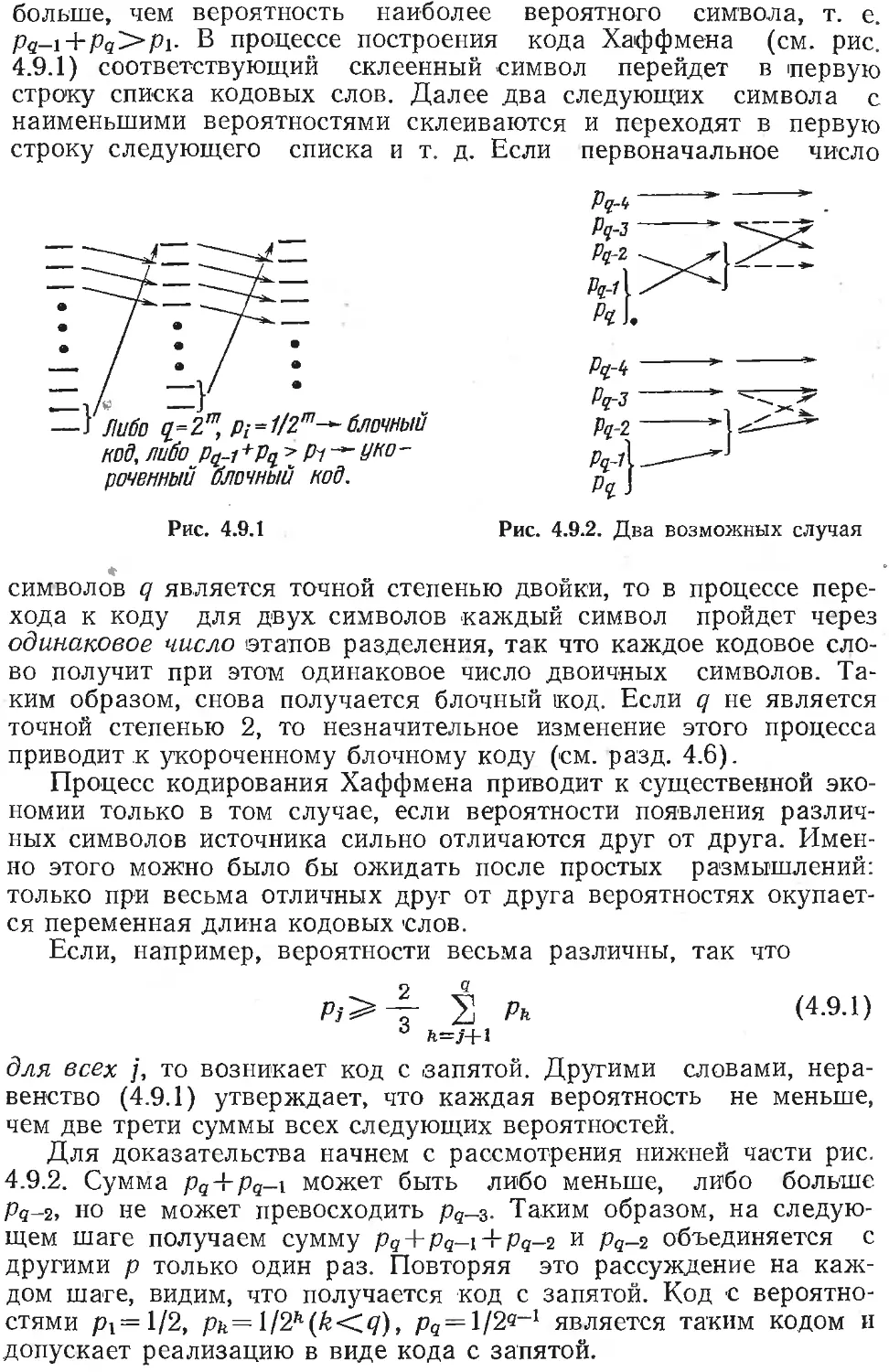

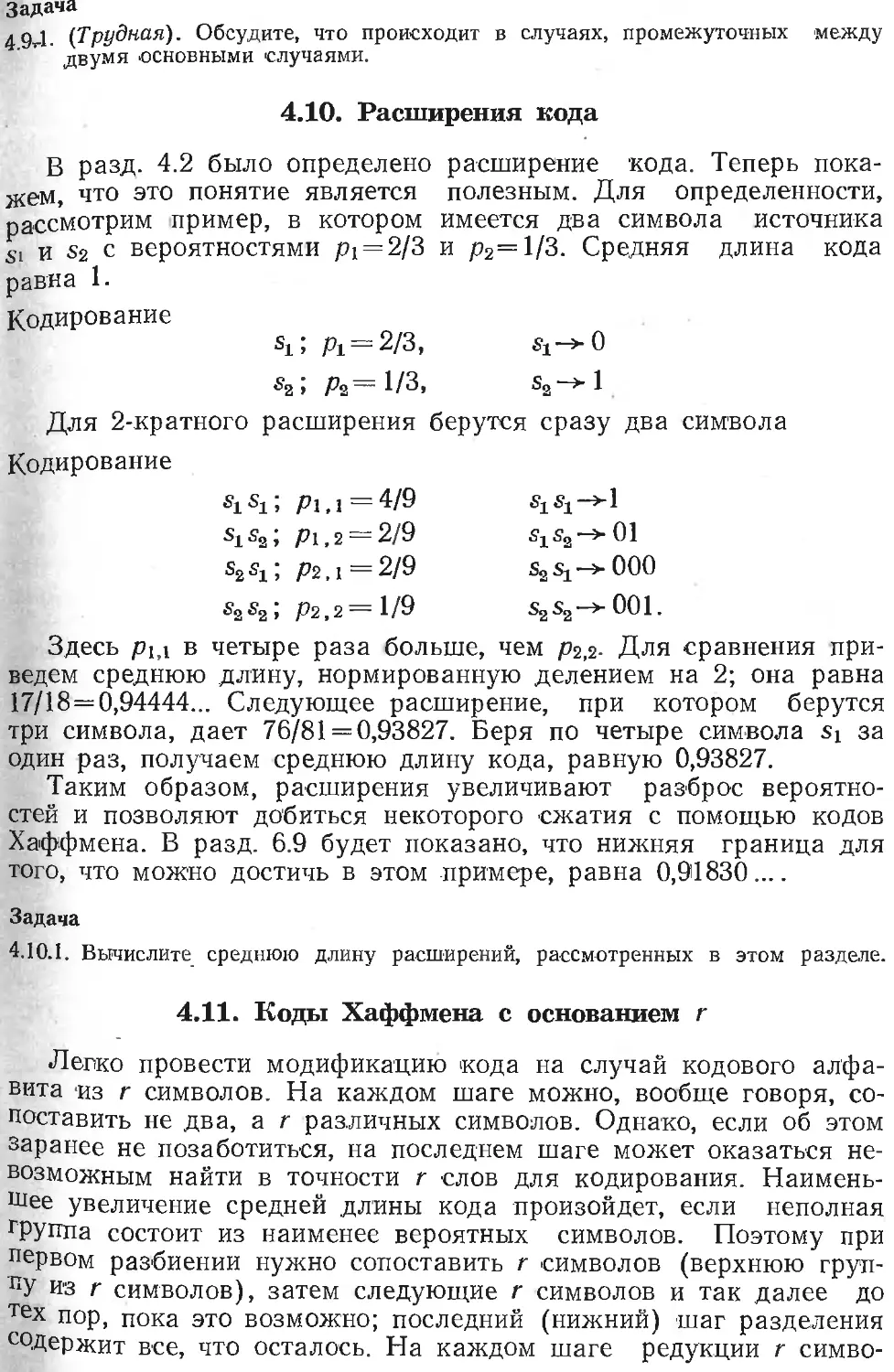

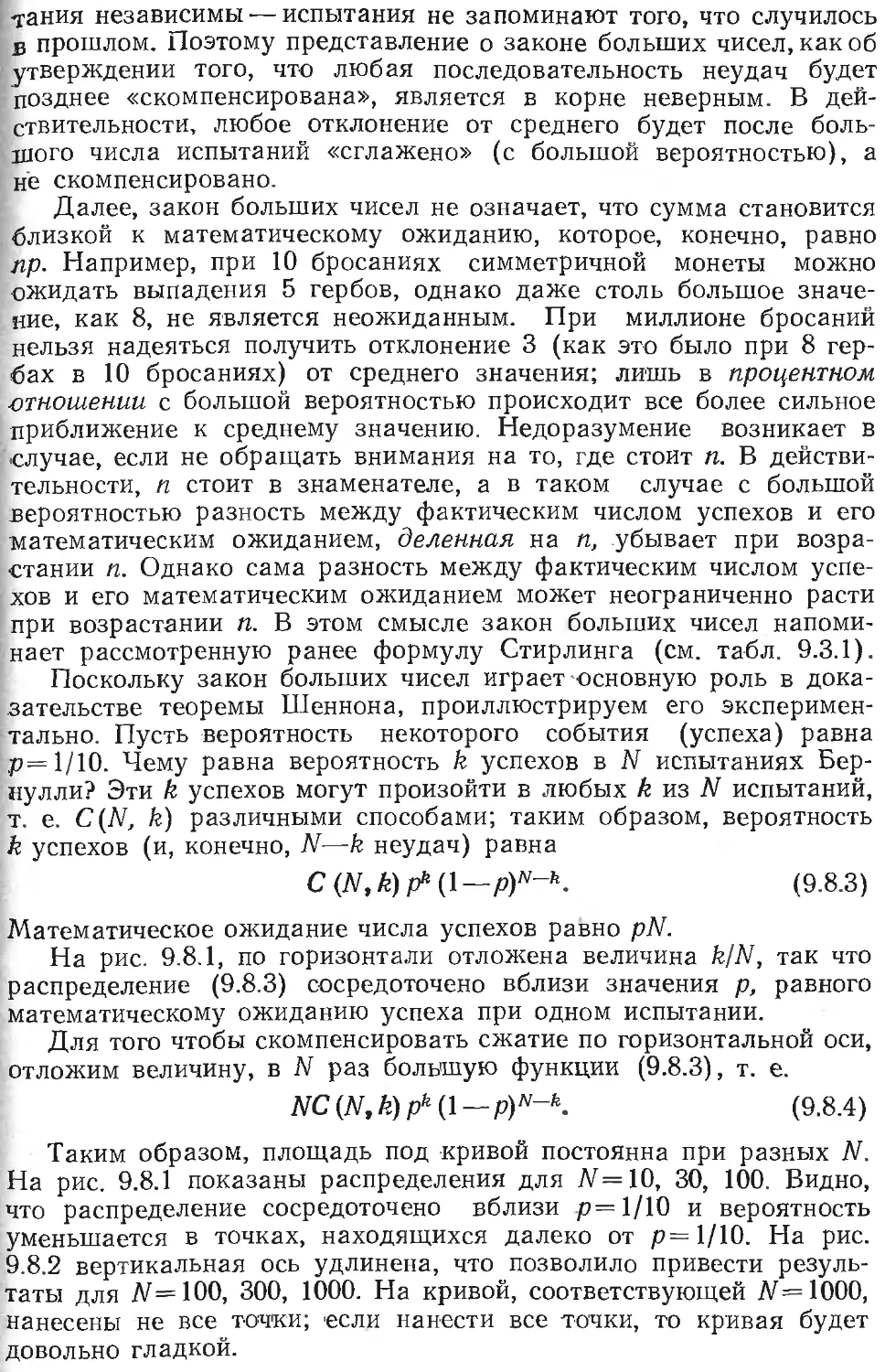

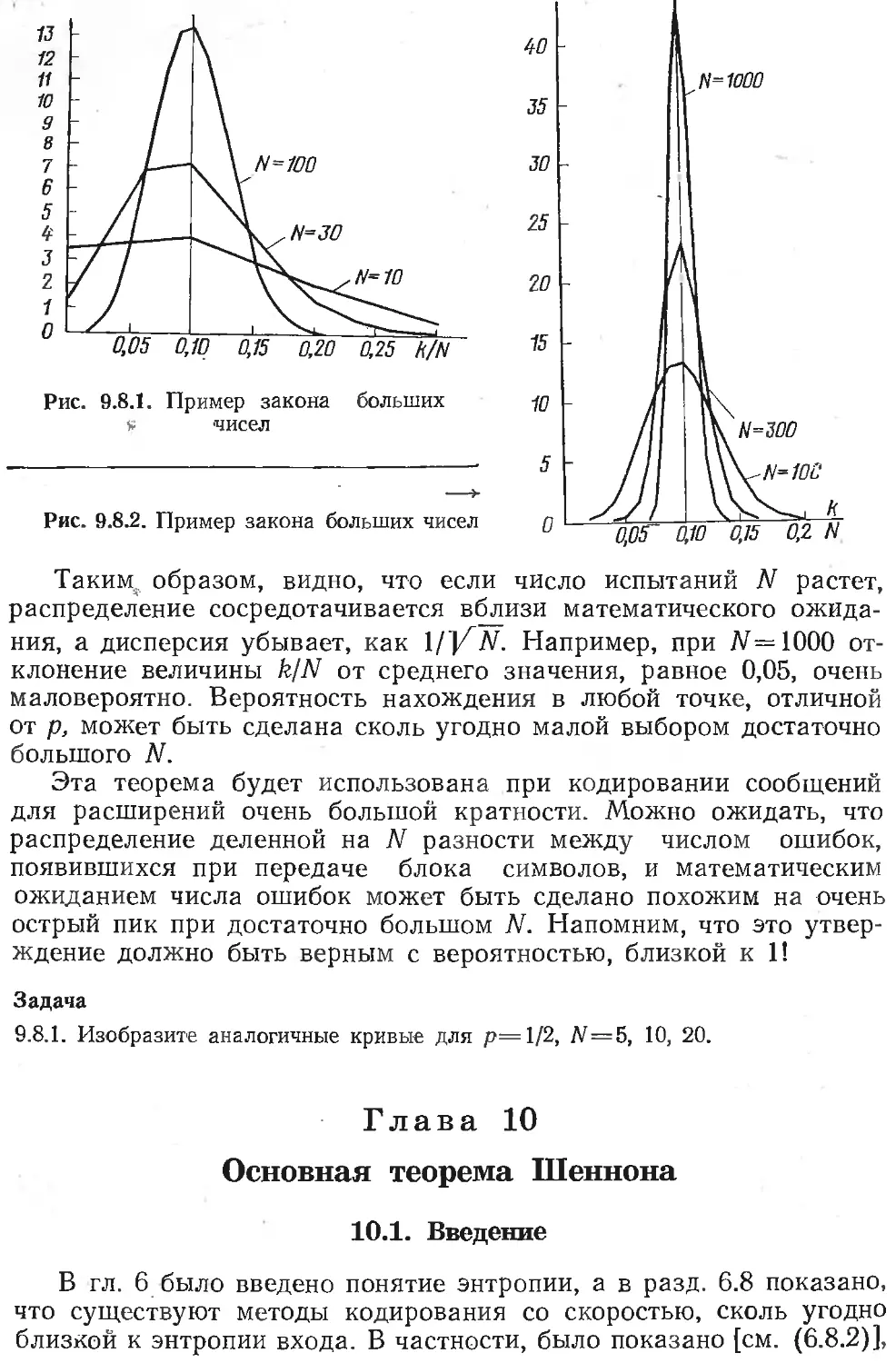

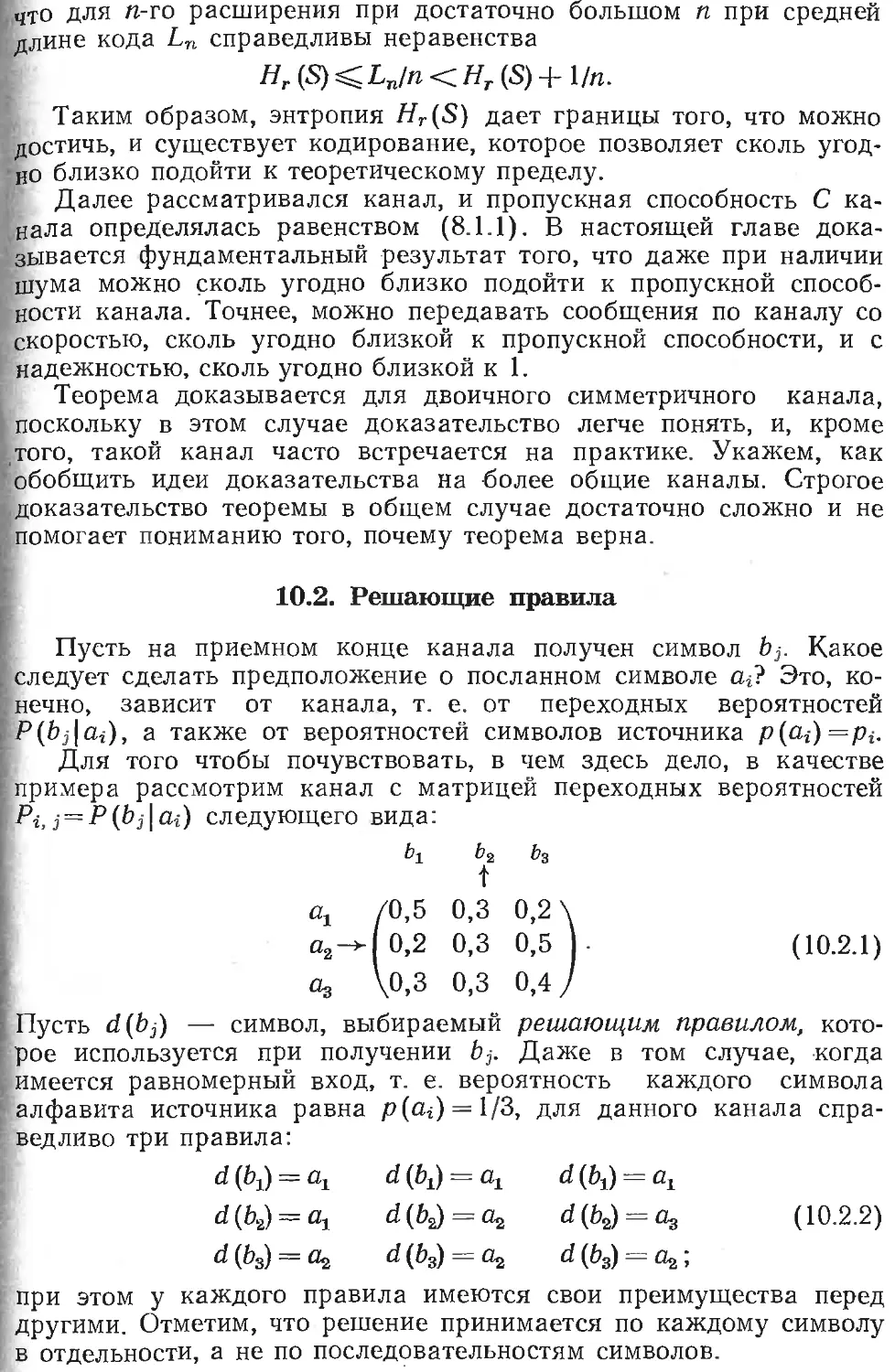

щих устройствах на электронно-лучевых трубках в ЭВМ NORC.