Автор: Кудряшов Б.Д.

Теги: электротехника кибернетика программирование компьютерные технологии

ISBN: 978-5-388-00178-8

Год: 2009

Текст

Теория

информации

Кодирование дискретных источников

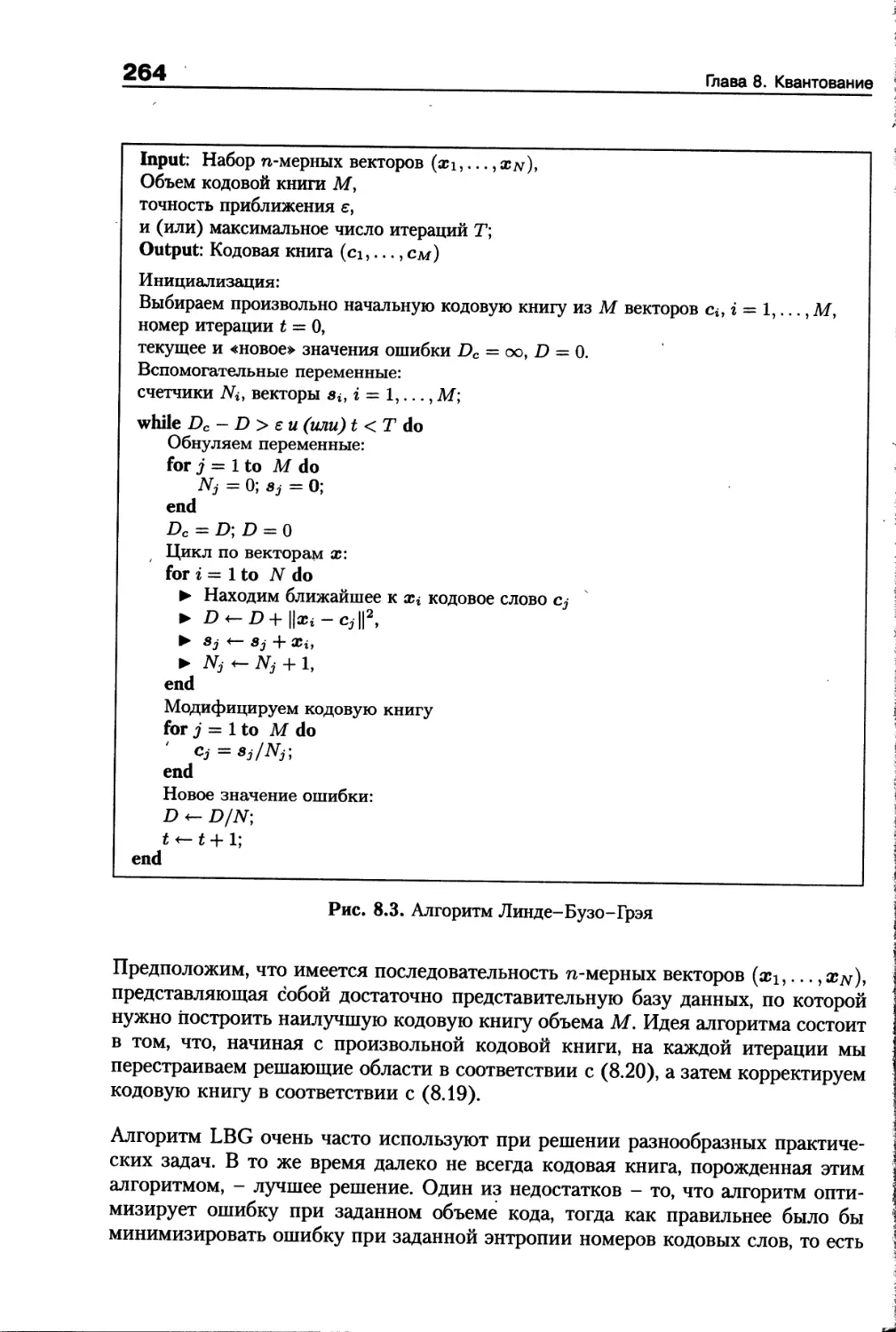

Кодирование информации

для передачи по каналу с шумом

Кодирование с заданным

критерием качества

ДОПУЩЕНО

УЧЕБНО-МЕТОДИЧЕСКИМ ОБЪЕДИНЕНИЕМ

УЧЕБНИК

Б. Д. Кудряшов

Теория

информации

Допущено Учебно-методическим объединением вузов по университетскому

политехническому образованию в качестве учебного пособия для студентов

высших учебных заведений, обучающихся по направлению подготовки

230200 «Информационные системы».

С^ППТЕР'

Москва - Санкт-Петербург - Нижний Новгород - Воронеж

Ростов-на-Дону - Екатеринбург - Самара - Новосибирск

Киев - Харьков - Минск

2009

ББК 32.811Я7

УДК 621.391(075)

К88

Рецензент:

Коржик В. И., заслуженный работник высшей школы России,

доктор технических наук, профессор Санкт-Петербургского

государственного университета телекоммуникаций

им. М. А. Бонч-Бруевича

Кудряшов Б. Д.

К88 Теория информации: Учебник для вузов. — СПб.: Питер, 2009. — 320 с.:

ил. — (Серия «Учебник для вузов»).

ISBN 978-5-388-Q0178-8

В учебнике описаны алгоритмы работы современных методов сжатия данных, спосо-

бы эффективного представления аналоговой информации, методы анализа эффективности

систем помехоустойчивого кодирования. В последние годы появилась техническая ли-

тература, в которой описываются конкретные алгоритмы сжатия данных, применяемые

в современных стандартах и коммерческих программных продуктах. Отличие данного

учебника от аналогов состоит в том, что новые методы обработки информации излагают-

ся с позиций теории информации, как часть общей теории. Такой подход представляется

важным для подготовки потенциальных исследователей и разработчиков перспективных

информационных технологий.

I

ББК 32.811я7

УДК 621.391 (075)

Все права защищены. Никакая часть данной книги не может быть воспроизведена в какой бы то ни было форме

без письменного разрешения владельцев авторских прав.

Информация, содержащаяся в данной книге, получена из источников, рассматриваемых издательством как

надежные. Тем не менее, имея в виду возможные человеческие или технические ошибки, издательство не может

гарантировать абсолютную точность и полноту приводимых сведений и не несет ответственности за возможные

ошибки, связанные с использованием книги.

ISBN 978-5-388-00178-8

© Кудряшов Б. Д., 2009

© ООО «Лидер», 2009

Краткое содержание

Предисловие.................................................8

Введение...................................................10

Глава 1. Энтропия дискретных источников....................12

Глава 2. Неравномерное кодирование дискретных источников...57

Глава 3. Кодирование дискретных источников

при неизвестной статистике.........................92

Глава 4. Алгоритмы кодирования источников,

применяемые в архиваторах.........................128

Глава 5. Кодирование для дискретных каналов с шумом.......168

Глава 6. Измерение информации,

порождаемой непрерывным источником.......................204

Глава 7. Кодирование источника с заданным критерием качества.224

Глава 8. Квантование......................................253

Глава 9. Кодирование для непрерывных каналов с шумом......289

Список литературы........................................ 304

Предметный указатель......................................308

Содержание

Предисловие.....................................................8

Введение....................................................... 10

Глава 1. Энтропия дискретных источников.........................12

1.1. Дискретные источники сообщений....................12

1.2. Измерение информации. Собственная информация......16

1.3. Энтропия..........................................18

1.4. Выпуклые функции многих переменных ...............23

1.5. Условная энтропия.................................27

1.6. Дискретные случайные последовательности. Цепи Маркова.30

1.7. Энтропия на сообщение дискретного

стационарного источника................................34

1.8. Равномерное кодирование дискретного источника.

Постановка задачи......................................38

1.9. Неравенство Чебышева. Закон больших чисел.........41

1.10. Прямая теорема кодирования

для дискретного постоянного источника..................43

1.11. Обратная теорема кодирования

для дискретного постоянного источника..................45

1.12. Множество типичных последовательностей для дискретного

постоянного источника. Источники с памятью.............48

1.13. Задачи...........................................51

1.14. Библиографические замечания......................55

Глава 2. Неравномерное кодирование дискретных источников.......57

2.1. Постановка задачи неравномерного

побуквенного кодирования...............................57

2.2. Неравенство Крафта................................60

2.3. Теоремы побуквенного неравномерного кодирования...63

2.4. Оптимальный побуквенный код — код Хаффмена........66

Содержание

5

2.5. Избыточность кода Хаффмена..........................69

2.6. Код Шеннона.........................................70

2.7. Код Гилберта-Мура...................................74

2.8. Неравномерное кодирование для стационарного источника...76

2.9. Задачи..............................................89

2.10. Библиографические замечания........................91

Глава 3. Кодирование дискретных источников

при неизвестной статистике.......................................92

3.1. Постановка задачи универсального кодирования источников.92

3.2. Несколько полезных комбинаторных формул.............95

3.3. Двухпроходное побуквенное кодирование...............98

3.4. Нумерационное кодирование..........................106

3.5. Асимптотические границы избыточности

универсального кодирования...............................113

3.6. Адаптивное кодирование.............................120

3.7. Сравнение алгоритмов...............................125

3.8. Задачи.............................................126

3.9. Библиографические замечания .......................127

Глава 4. Алгоритмы кодирования источников,

применяемые в архиваторах.......................................128

4.1. Монотонные коды....................................129

4.2. Интервальное кодирование и метод «стопка книг»...133

4.3. Метод скользящего словаря (LZ-77)..................138

4.4. Алгоритм LZW (LZ-78)...............................145

4.5. Предсказание по частичному совпадению..............149

4.6. Сжатие с использованием преобразования

Барроуза-Уилера...........................................155

4.7. Сравнение способов кодирования.

Характеристики архиваторов................................164

4.8. Задачи.............................................166

4.9. Библиографические замечания........................167

Глава 5. Кодирование для дискретных каналов с шумом..................168

5.1. Постановка задачи помехоустойчивого кодирования....169

5.2. Модели каналов.....................................172

5.3. Взаимная информация. Средняя взаимная информация ..175

6

Содержание

5.4. Условная средняя взаимная информация.

Теорема о переработке информации........................178

5,5. Выпуклость средней взаимной информации.............180

5.6. Информационная емкость и пропускная способность....181

5.7. Неравенство Фано...................................183

5.8. Обратная теорема кодирования.......................187

5.9. Вычисление информационной емкости

каналов без памяти......................................188

5.10. Симметричные каналы ............................. 191

5.11. Прямая теорема кодирования

для дискретных постоянных каналов...................196

5.12. Типичные пары последовательностей.................200

5.13. Задачи............................................202

5.14. Библиографические замечания.......................203

Глава 6. Измерение информации,

порождаемой непрерывным источником..............................204

6.1. Непрерывные вероятностные ансамбли.................205

6.2. Дифференциальная энтропия. Взаимная информация

для непрерывных ансамблей............................206

6.3. Дифференциальная энтропия случайных векторов.......211

6.4. Дифференциальная энтропия стационарных процессов

дискретного времени.....................................214

6.5. Связь с энтропией дискретного ансамбля.

Множество типичных последовательностей

для непрерывного источника..............................219

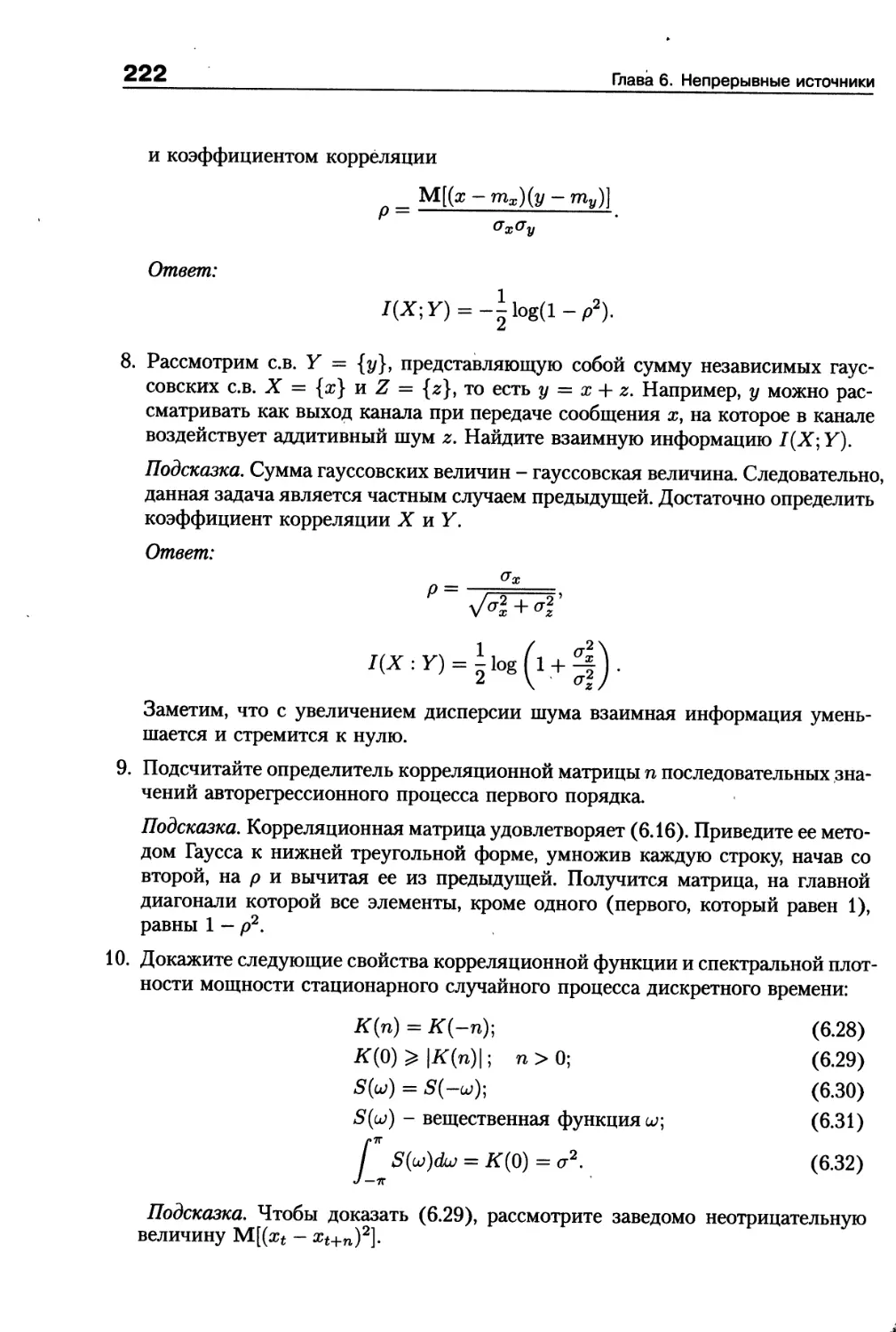

6.6. Задачи.............................................221

6.7. Терминологические и библиографические замечания....223

Глава 7. Кодирование источника с заданным критерием качества....224

7.1. Меры искажения. Постановка задачи кодирования......225

7.2. Свойства функции скорость-искажение................228

7.3. Простые примеры вычисления

функции скорость-искажение............................. 231

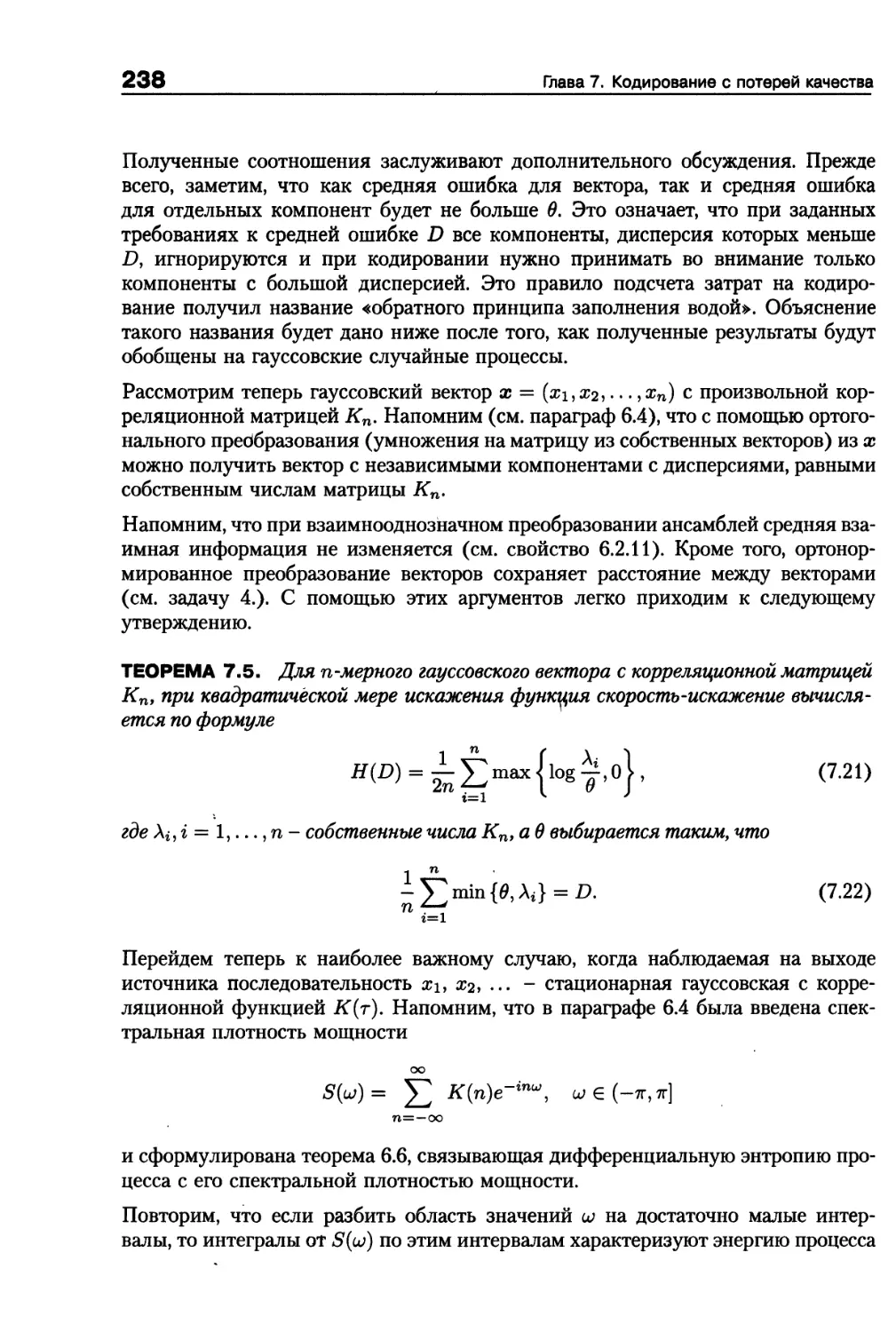

7.4. Функция скорость-искажение для гауссовских

последовательностей.....................................236

7.5. Обратная теорема кодирования для дискретного

постоянного источника при заданном критерии качества....240

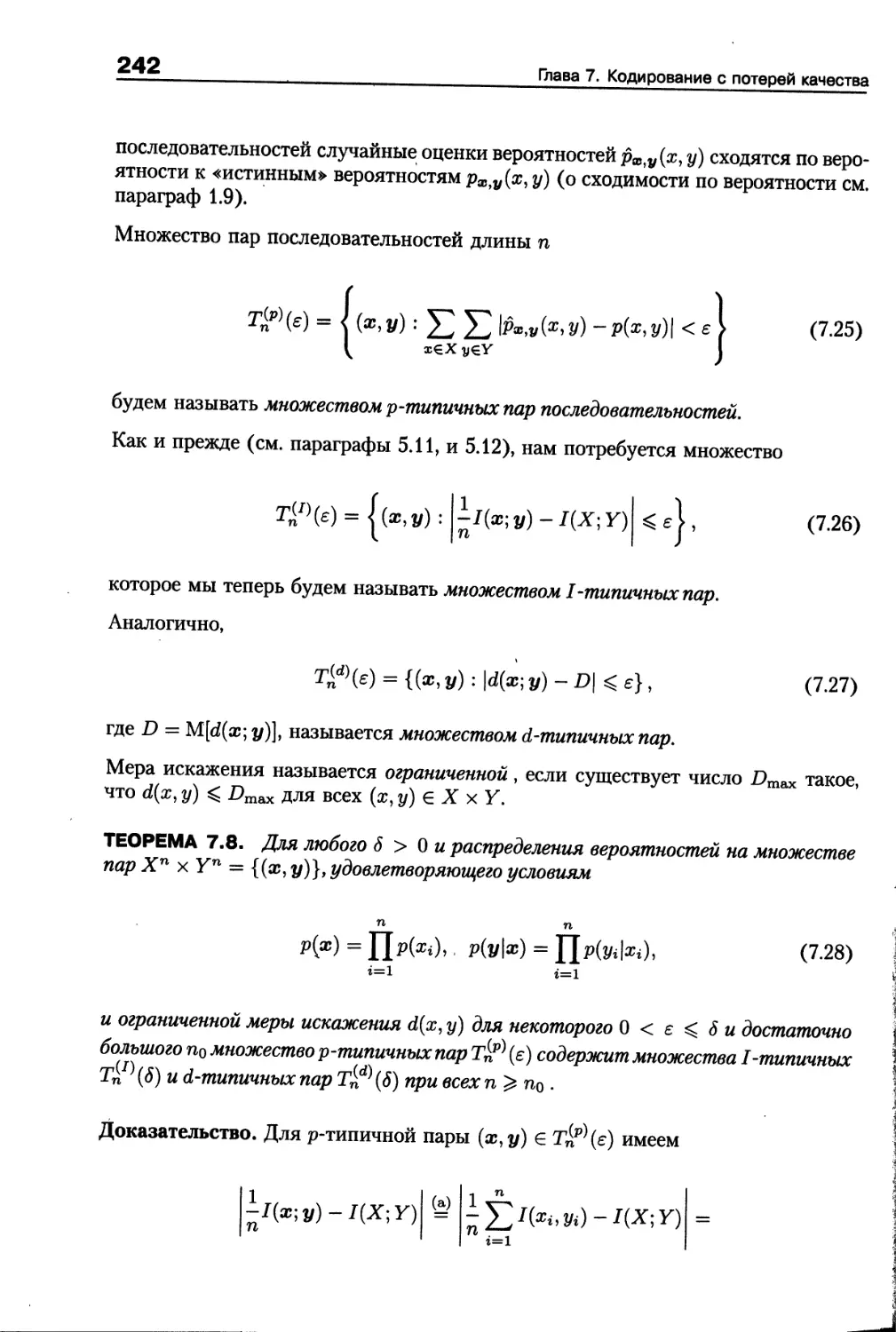

7.6. Множества типичных пар последовательностей.........241

Содержание

7

7.7. Прямая теорема кодирования для дискретного

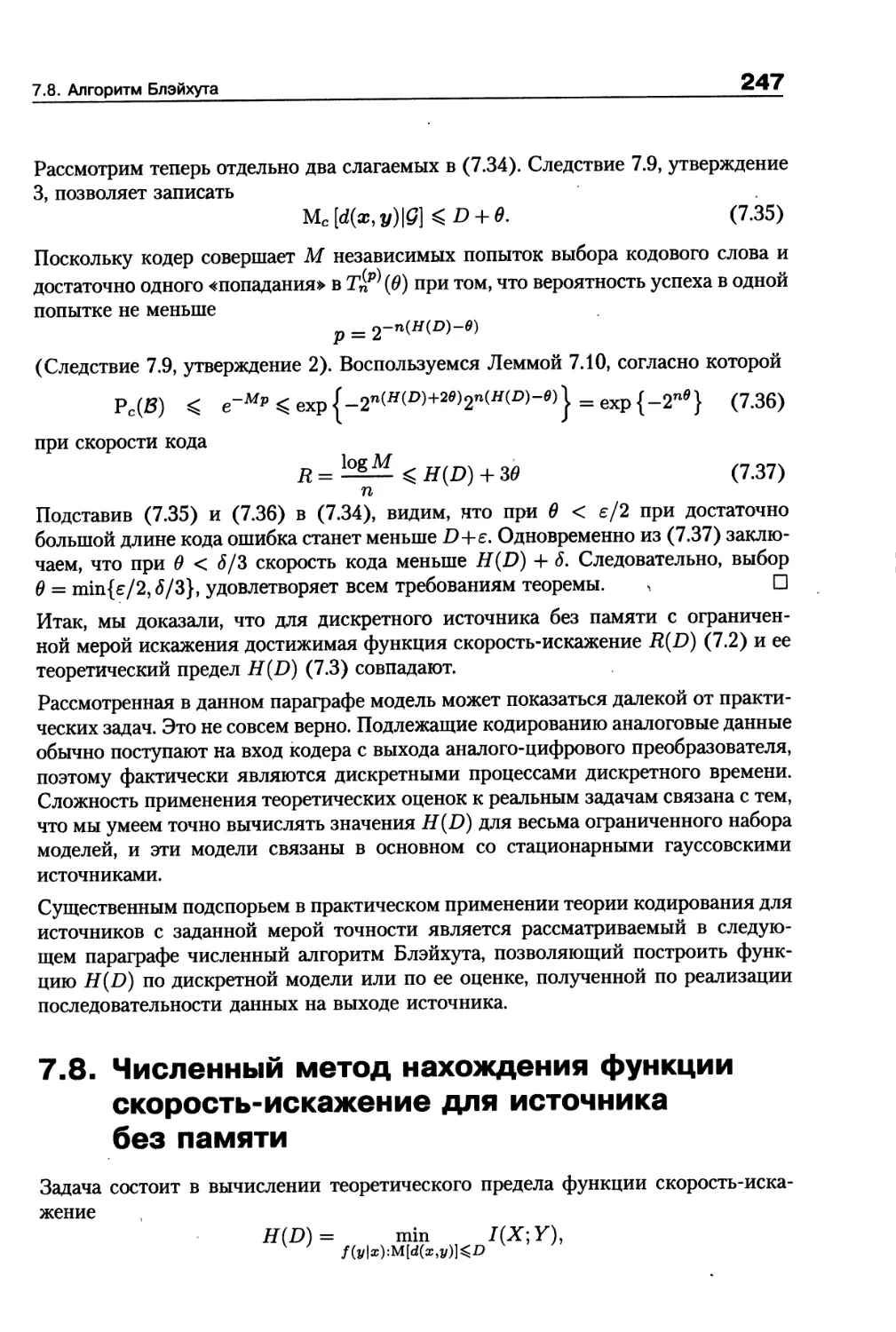

постоянного источника при заданном критерии качества......244

7.8. Численный метод нахождения функции

скорость-искажение для источника без памяти...............247

7.9. Задачи...............................................251

7.10. Терминологические и библиографические замечания.....252

Глава 8. Квантование..............................................253

8.1. Скалярное квантование................................254

8.2. Векторное квантование................................262

8.3. Квантователи на основе числовых решеток..............265

8.4. Решетки на основе линейных кодов.

Сложность квантования.....................................278

8.5. Квантование с помощью решеток

на основе сверточных кодов................................283

8.6. Задачи...............................................288

8.7. Библиографические замечания..........................288

Глава 9. Кодирование для непрерывных каналов с шумом..............289

9.1. Каналы дискретного времени...........................289

9.2. Канал непрерывного времени с аддитивным

белым гауссовским шумом...................................292

9.3. Энергетический выигрыш кодирования...................296

9.4. Задачи...............................................303

9.5. Библиографические замечания .........................303

Список литературы.................................................304

Предметный указатель..............................................308

Предисловие

В наши дни уже нет необходимости объяснять, насколько важны информацион-

ные технологии вообще и теория информации в частности. Хотелось бы объяс-

нить, для чего написана эта конкретная книга и какие пробелы в существующей

литературе она заполняет.

Фундаментальный учебник В. Д. Колесника и Г. Ш. Полтырева [7], изданный

в 1982 году, покрывает все основные разделы Шенноновской теории информации

и почти совсем не утратил актуальности как вузовское пособие для студен-

тов. Действительно, набор основных сведений, представляющих собой основы

теории, остался прежним. Вот что существенно изменилось за четверть века, про-

шедшие с момента публикации учебника - это связь между теорией и практикой.

То, что в 80-е годы воспринималось как абстрактное математическое упражнение,

сегодня - решение конкретной практической задачи. Именно поэтому изме-

нилось и представление о подборе материала для краткого курса и о степени

важности различных понятий и разделов теории информации для подготовки

инженеров в области информационных технологий.

Представляемый вниманию читателя учебник ставит своей целью объяснить

с позиций теории информации, как работают те самые методы, которыми чита-

тель пользуется ежедневно, когда пользуется архиваторами файлов, слушает му-

зыку воспроизводимую МПЗ-проигрывателем, разговаривает по мобильному теле-

фону или смотрит фильм, записанный на DVD. Хотелось бы убедить студента

в том, что все это не так уж сложно, по крайней мере, для человека, воору-

женного знанием элементарных основ теории, фундамент которой был заложен

К. Шенноном еще в 1948 году.

Содержание книги формировалось, с одной стороны, в процессе многих лет пре-

подавания теории информации студентам технического вуза, с другой стороны -

в результате исследовательской работы в рамках проектов, связанных с разра-

боткой систем сжатия данных, сжатия речи, аудио- и видеоинформации, а также

систем модуляции и помехоустойчивого кодирования. Таким образом, данный

учебник - попытка смешать в правильной пропорции элементарные сведения

из комбинаторики и теории вероятностей, теоремы теории информации и кон-

кретные алгоритмы обработки информации с тем, чтобы получился легкий для

усвоения и полезный для читателя продукт.

Предисловие

9

Автор считает своим приятным долгом выразить свою признательность Г. Ш. Пол-

тыреву и В. Д. Колеснику, у которых автор учился теории информации (и мно-

гому другому) и продолжает учиться до сих пор. В. Д. Колесник читал рукопись

данного учебника и сделал много полезных замечаний, способствовавших его

улучшению. Практическая работа в разнообразных приложениях теории инфор-

мации стала возможной благодаря сотрудничеству с Г. Тененгольцем. Его под-

держка и полученный с его помощью помощью опыт неоценимы. Многие аспекты

сжатия информации автор обсуждал с Ю. М. Штарьковым. Эти дискуссии, а

также семинары Ю. М. Штарькова в большой степени повлияли на содержание

учебника.

В течение многих лет автор проводил совместные исследования с Р. Йоханнессо-

ном и его аспирантами в Университете г. Лунд (Швеция). Творческая обстановка

на кафедре Информационных технологий способствовала увлекательному и пло-

дотворному научному поиску, а личный пример Р. Йоханнессона помог лучше

понять, чему и как следует учить студентов.

Автор благодарен Лундскому университету, а также Университету г. Ульм (Гер-

мания) и компании Самсунг (Корея) за финансовую поддержку теоретических

и прикладных исследований в последние несколько лет.

Без сомнения, самыми важными были помощь и бескопромиссная критика жены

и соратника И. Е. Бочаровой. Содержание глав, посвященных кодированию ана-

логовых источников, интенсивно обсуждалось с ней и поэтому существенно пере-

секается с содержанием соответствующих разделов ее учебника [32}.

Введение

Теория информации наука с точно известной датой рождения. Ее появление на

свет связывают с публикацией работы Клода Шеннона «Математическая теория

связи» (1948) [20]. С тех пор теория информации прошла большой путь, обога-

тилась огромным числом интересных научных открытий и доказала свою прак-

тическую важность. Сегодня в повседневный обиход вошли высокоскоростные

модемы для телефонных каналов, лазерные компакт-диски для хранения инфор-

мации, жесткие диски большой емкости для персональных компьютеров, мобиль-

ные телефонные аппараты для сотовых систем связи и многие другие устрой-

ства, создание которых было бы невозможно без привлечения методологии и

математического аппарата, разработанных в рамках теории информации.

Хотя теории информации часто приписывают несколько более широкое значе-

ние, применяя ее методологию в естествознании и искусстве, с точки зрения

самого Шеннона, она может корректно рассматриваться только как раздел мате-

матической теории связи. Поэтому круг задач теории информации мы поясним

с помощью представленной на рис. В.1 структурной схемы типичной системы

передачи или хранения информации. В этой схеме под источником понима-

Рис. В.1. Блок-схема системы связи

ется любое устройство или объект живой природы, порождающие сообщения,

которые должны быть перемещены в пространстве или во времени. Это может

быть клавиатура компьютера, человек, аналоговый выход видеокамеры и т.п.

Поскольку, независимо от изначальной физической природы, все подлежащие

передаче сообщения обычно преобразуются в форму электрических сигналов,

именно такие сигналы мы и будем рассматривать как выход источника.

Цель кодера источника - представление информации в наиболее компактной

форме. Это нужно для того, чтобы максимально эффективно использовать ресур-

сы канала связи либо запоминающего устройства.

Введение

11

Далее следует кодер канала, задачей которого является обработка информации

с целью защиты сообщений от помех при передаче по каналу связи либо от воз-

можных искажений при хранении информации. Модулятор служит для преоб-

разования сообщений, формируемых кодером канала, в сигналы, согласованные

с физической природой канала связи или средой накопителя информации.

Остальные блоки, расположенные на приемной стороне, выполняют обратные

операции и предоставляют информацию ее получателю в удобном для исполь-

зования виде.

Итак, в теории информации можно выделить следующие разделы:

► Кодирование дискретных источников. Иногда эту часть теории информации

называют кодированием без потерь, кодированием для канала без шума, сжа-

тием информации.

► Кодирование информации для передачи по каналу с шумом. Речь идет о защите

информации от помех в каналах связи.

► Кодирование с заданным критерием качества. В некоторых системах связи

искажения информации считаются допустимыми. Более того, информация

аналоговых источников вообще не может быть представлена в цифровой форме

без искажений. В данной главе речь идет о методах кодирования, обеспечиваю-

щих наилучший компромисс между качеством (оцениваемым некоторой объ-

ективной мерой искажения) и затратами на передачу информации. Сегодня

задачи такого типа стали особенно актуальны, поскольку они находят широкое

применение для цифровой передачи речи, видео- и аудиоинформации.

► Кодирование информации для систем со многими пользователями. Здесь обсуж-

дается оптимальное взаимодействие абонентов, использующих какой-либо

общий ресурс, например канал связи. Примеры систем с множественным досту-

пом - системы мобильной связи, локальные сети ЭВМ.

► Секретная связь, системы защиты информации от несанкционированного дос-

тупа. Здесь также можно указать широкий круг актуальных задач, лежащих

на стыке теории информации, теории вычислительной сложности алгоритмов,

исследования операций, теории чисел.

Из перечисленных разделов в данном пособии рассматриваются первые три.

Глава 1 Энтропия дискретных

источников

1.1. Дискретные источники сообщений

Цель этого параграфа - напомнить те понятия, определения и формулы теории

вероятностей, которыми мы будем пользоваться в дальнейшем.

Будем обозначать через X некоторое дискретное множество, то есть множество,

содержащее конечное или счетное количество элементов х G X. Элементы мно-

жества X назовем элементарными событиями, непустые подмножества А с X

мы называем событиями. Через | А| мы обозначаем мощность множества А (коли-

чество элементов в А), Если |А| > 1, такое событие называется сложным собы-

тием. В рамках теории информации подмножества X называются сообщениями,

а элементарные события х е X - элементарными сообщениями.

Напомним, что множество чисел {р(ж)}? х € X, задает распределение вероятно-

стей на дискретном множестве X = {ж}, если все числа р(х) неотрицательны и

удовлетворяют условию нормировки 52 р(я) = 1-

хЕХ

Вероятность сложного события А определяется как

Р(А) = ^р(х).

хЕА

Множество сообщений X в совокупности с распределением вероятностей {р(ж)},

х е X, образуют дискретный вероятностный ансамбль X = {ж,р(ж)|.

Рассмотрим множество П всевозможных подмножеств множества X. Заметим,

что если X - конечное множество, содержащее |Х| = N элементов, то количество

различных подмножеств будет |П| = 2N. Элементами П являются элементар-

ные и сложные события из X, пустое (невозможное) событие 0, достоверное

событие X, Для любого А е П определена операция взятия дополнения Ас, ддя

любой йары множеств А, В е Q определены операции объединения событий

АиВ и пересечения событий АГ)В. Иначе их называют суммой и произведением

событий соответственно. Для произведения событий мы будем пользоваться обо-

значением АВ = АПВ. Перечисленные операции над событиями определяют

множество Q как булеву алгебру событий. Справедливы формулы

1.1. Дискретные источники сообщений

13

Р(0) = 0;

Р(Х) = 1;

Р(АС) = 1 - Р(А);

Р(А U В) = Р(А) + Р(В) - Р(АВ).

События несовместны, если их пересечение - пустое множество. Для несов-

местных событий вероятность объединения равна сумме вероятностей событий.

Если условие несовместности не выполнено, вероятность объединения стано-

вится меньше суммы вероятностей. Это верно для любого числа событий. Оценка

м м

п U Е

т=1 тп=1

называется аддитивной оценкой вероятности суммы событий. Равенство в этой

оценке достигается только для несовместных событий.

Для произвольной пары событий А,В С X условной вероятностью события А

при условии В называется величина

при Р(В) =4 0 и величина Р(А\В) = 0 при Р(В) = 0.

Из этого определения следует

Р(АВ) = Р(А\В)Р(В).

Для совокупности произвольного числа событий из этой формулы выводится

соотношение

Р(Л ... Ап) = Р(А1)Р(А2\А1)Р(А3\А1А2)... P(An|A ... An-i).

События А,В С Xназывают независимыми, если

Р(АВ) = Р(А)Р(В).

Совместно независимыми называют события Аь ..., Ап С X такие, что

Р(АХ... An) = P(Ai)P(A2)... Р(АП).

Если А, В С X - независимые события, то

Р(А|В) - Р(А); Р(В|А) = Р(В).

м

Пусть несовместные события В1,...,Ям таковы, что Р( |J Нт) = 1. Такой

171=1

набор событий иногда удобно рассматривать как систему «гипотез» по отноше-

нию к заданному событию А. Имеет место формула полной вероятности

м

Р(А) = £ Р(А\Нт)Р(Нт)

т=1 *

14

Глава 1. Энтропия дискретных источников

и формула апостериорной вероятности, или формула Байеса,

Е Р(А\Нт)Р(Нт)

т—1

Произведением множеств X и Y называется множество

Z = XY = {(х,у) : х е Х,у G Y} -

множество упорядоченных пар, первый элемент которых принадлежит множе-

ству X, а второй - множеству У. Хотя обозначения для произведения множеств и

произведения (пересечения) событий совпадают, смысл этих понятий, очевидно,

различен. Какое из двух понятий имеется в виду, ясно из контекста.

Нетрудно подсчитать число элементов в множестве Z = XY:

|ХУ| = |Х|-|У|.

Перемножая произвольное число п множеств Х2, ..., Хп, получаем мно-

жество последовательностей длины п, составленных из элементов множеств-

сомножителей. В частном случае, когда все множества одинаковы, Xi = Х2 =

= ... = Хп = X, используется краткая запись

Х1%2 ...хп = хп = {Сп,..., хп) : Xi е X,i = 1,... ,п} .

Чтобы определить произведение вероятностных ансамблей X = {х,рх(х)} и

У = {?/,ру(?/)}, нужно на произведении множеств XY задать совместное рас-

пределение вероятностей {рху(х,у)}. В результате получим ансамбль XY =

= {(х>У))Рху(х,у)}‘ Нижний индекс при распределениях вероятностей указы-

вает, на каком множестве определено данное распределение. Этот индекс мы

указываем только в тех случаях, когда это важнр для однозначности понимания.

Определение произведения вероятностных ансамблей естественным образом рас-

пространяется на произвольное число ансамблей-сомножителей. Число сомно-

жителей п называют размерностью ансамбля-произведения, соответствующее

распределение вероятностей - многомерным (n-мерным). Если задано п-мерное

распределение, тем самым заданы и распределения для меньших размерностей.

В частности, для произведения двух ансамблей имеем

и®) = р(х’У)>

yeY

р(у) = 52 р(х> у)-

хех

Условным распределением вероятностей на элементах множества X при фикси-

рованном элементе у G У называется распределение

?(Ф) = <

Р(я?>у)

р(у) ’

если р(у) / О,

О в противном случае,

хеХ.

\

1.1. Дискретные источники сообщений

15

Ансамбли X и Y независимы, если имеют место тождества

р(ж, у) = р(х)р(у\ хеХ, у е У.

Используя эти понятия, легко обобщить формулу перемножения вероятностей,

формулу полной вероятности и формулу Байеса на произведение вероятностных

ансамблей. Например, справедлива формула

р(ж1,... ,хп) = р(ж1)р(ж2|ж1)р(жз|ж1ж2).. .р(жп|ж1,..., жп_1).

Большую роль в теории информации играют случайные ансамбли, элементы

которых - числа. Такие ансамбли являются случайными величинами. Матема-

тическим ожиданием случайной величины х е X называется

и = 52 хр(хУ

хех

Для произвольного множества X можно определить функцию р(х), х е X, при-

нимающую вещественные значения. Тем самым устанавливается отображение

X на множество вещественных чисел. Новый вероятностный ансамбль с мно-

жеством значений У = {у = ^(я)} является случайной величиной. Для вычис-

ления математического ожидания величины у не обязательно знать распреде-

ление вероятностей ру(у) для у. Имея распределение рх(ж) на X, величину

Му [у] можно получить, если воспользоваться следующим полезным свойством

математического ожидания:

Му[у] = Мх[ф)] = ^2 ф(х)Рх(х). (1.1)

х^Х

Действительно,

мИу] = 52 ур^{у) = 52у 12 рх^=

y£Y yeY х:<р(х)=у

= 52 52 урх (ж)= 52 52 = ^2

у€У х:<р(х)=у y£Y х:<р(х)=у хЕХ

Другими важными характеристиками случайных величин являются дисперсия

Dx [ж] = Мх Мх И)2]

и корреляционный момент

КХу{х, у) = Мху [(ж - М [ж]) (?/ - М [у])].

В определениях математического ожидания, дисперсии и корреляционного

момента нижние индексы указывают на ансамбли, по которым производится

усреднение. Мы будем писать этот индекс только в том случае, если из контекста

непонятно, о каком ансамбле идет речь.

Если для двух случайных величин корреляционный момент равен нулю, случай-

ные величины называют некоррелированными. Напомним следующие свойства

числовых характеристик:

16

Глава 1. Энтропия дискретных источников

1. Для любых случайных величин х и у

М [ж + у] = М [ж] + М [?/].

2. Если с - константа, а х - случайная величина, то

М [сж] = сМ [ж].

3. Если х и у - независимые случайные величины, то

М [од] = М [ж] М [у].

4. Для некоррелированных случайных величин х и у

D [ж + у] = D [ж] + D [?/].

5. Если с - константа, а х - случайная величина, то

D [ся] = c2D [ж] .

6. Если с - константа, а х - случайная величина, то

D [с + ж] = D [ж].

7. Если х и у независимы, то К(х,у) = 0, то есть из независимости случайных

величин следует их некоррелированность. Обратное, вообще говоря, неверно.

Доказательство этих свойств - полезное упражнение на применение правила

(1.1).

1.2. Измерение информации.

Собственная информация

Задача количественного измерения информации возникла при решении кон-

кретных практических задач. Можно не сомневаться, что первоначальным моти-

вом было стремление уменьшить количество электрических сигналов, необхо-

димых для передачи сообщений по каналам связи. Поэтому разумной мерой

информации, содержащейся в сообщении, является мера, монотонно связанная

с затратами на передачу сообщения.

Условимся также о том, что сообщения представляют собой случайные события

(по крайней мере, с точки зрения получателя информации). Рассмотрим в каче-

стве источника произвольное дискретное множество X, и каждой букве х е X

припишем вероятность р(х).

Сформулируем интуитивные требования к мере ^(ж), определенной для всех

х е X, которую следует принять как меру информации, содержащейся в сооб-

щениях ансамбля X = {х,р(х)}.

► Поскольку предполагается, что эта мера будет определять затраты, связанные

с передачей или хранением сообщений, мера должна быть неотрицательной.

1.2. Измерение информации. Собственная информация

17

► Поскольку для нас несущественно, каким образом будут интерпретированы

и использованы передаваемые сообщения, мера должна однозначно опреде-

ляться вероятностью сообщения. Поэтому вместо будем писать ^(р(ж)).

► Установим характер зависимости меры от вероятности сообщений. Пусть име-

ется множество из двух равновероятных сообщений и стоит задача кодирова-

ния сообщений этого множества двоичными символами алфавита А = {0,1}.

Интуитивно ясно, что неплохой способ кодирования состоит в том, чтобы

сопоставить одному из сообщений символ 0, а другому - символ 1. Точно

также для кодирования четырех равновероятных сообщений можно исполь-

зовать последовательности длины 2, для восьми сообщений - длины 3 и т.д.

В этих примерах вероятностям 1/2, 1/4, 1/8, ...соответствовали затраты на

передачу, равные 1, 2, 3, ...единицам информационной меры соответственно.

Следовательно, разумно потребовать, чтобы мера информации удовлетворяла

соотношению м(Рт) = шм(р)-

► Рассмотрим последовательность сообщений xi, ..., хп, выбираемых незави-

симо из одного и того же множества X с одним и тем же распределением веро-

ятностей {р(ж)|. Из статистической независимости сообщений следует, что

знание предыдущих сообщений не помогает предугадать следующие. Поэтому

затраты на передачу последовательности складываются из затрат на пере-

дачу каждого отдельного сообщения. Получаем еще одно разумное требование

к информационной мере:

/1(^1,..., хп) = /4^1) +... + м(^п)

для независимых сообщений xi,..., хп.

Перечисленные требования к информационной мере приводят нас к следующему

определению.

Собственной информацией 1(х) сообщения ж, выбираемого из дискретного ан-

самбля X = {ж,р(ж)}, называется величина, вычисляемая по формуле

1{х) = -logp(:r). (1.2)

В этой формуле не указано основание логарифма. Мы и дальше не будем его

указывать, всякий раз подразумевая, что логарифмы вычисляются по основа-

нию 2, если не оговорено другое. Это соответствует измерению информации

в битах. Если бы логарифм вычислялся по натуральному основанию, единицей

измерения информацией стал бы нат. Если основание десятичное - информация

измеряется в Хартли (в честь Хартли, который использовал формулу (1.2) еще

до Шеннона). Биты удобнее, поскольку они сразу показывают, сколько двоичных

символов надо потратить на передачу сообщения. В теоретико-информационных

исследованиях часто предпочитают наты, поскольку In х удобнее дифференци-

ровать, чем log х. Мы будем пользоваться битами.

Из определения собственной информации и свойств логарифма непосредственно

вытекают следующие свойства собственной информации:

18

Глава 1. Энтропия дискретных источников

► Неотрицательность: 1(х) 0, ж е X.

► Монотонность: если xi,x2 € X, p(zi) то I(a?i) /(я2).

► Аддитивность. Для независимых сообщений xi,..., хп имеет место равенство

п

Т(ж1, • • •, хп) = I(xi).

г=1

Пример 1.2.1. Пусть X = {а, 5, c,d} и вероятности букв будут р(а) = 1/2,

р(Ь) = 1/4, р(с) = p(d) = 1/8. Тогда собственные информации букв равны

/(а) = 1, 1(b) = 2, 1(c) = 1(d) = 3 бит. Легко указать способ кодирования, при

котором на каждую букву будет затрачено по два бита. Наша мера информации

показывает, что на самом деле буквы несут различное количество информации,

и, может быть, разумнее тратить различное число битов на передачу различных

букв (как в азбуке Морзе). Позже мы вернемся к этому примеру и проверим

наше предположение.

Пример 1.2.2. Пусть X = {а, Ь} и вероятности букв будут р(а) = 0,05, р(Ь) =

= 0,95. Тогда 1(a) = 4,322,1(b) = 0,216. Мы получили дробные числа. Более того,

передача одного из двух символов может потребовать больше 4 битов информа-

ции! На второй символ предлагается тратить примерно 1/5 бита. Это на первый

взгляд кажется невозможным. Однако, как мы увидим позже, тратить целый бит

на передачу каждой буквы рассматриваемого источника - непозволительная

роскошь.

Нельзя ли было использовать для измерения информации другую функцию?

Этот вопрос поднимался много раз как на заре теории информации, так и

в последние годы. Доказано, что при предположениях, сформулированных выше

(и некоторых других предположениях, касающихся непрерывности и дифферен-

цируемости информационной меры), информационная мера единственна

с точностью до постоянного множителя, то есть с точностью до выбора основания

логарифма.

1.3. Энтропия

Определенная в предыдущем параграфе мера информации, содержащейся в сооб-

щении, представляет собой случайную величину. Собственная информация сооб-

щения х дискретного ансамбля X = {х,р(х)} характеризует «информативность»

или «степень неожиданности» конкретного сообщения. Среднее значение или

математическое ожидание этой величинь! по ансамблю X = {х,р(х)} будет харак-

теристикой информативности всего ансамбля.

Энтропией дискретного ансамбля X = {ж,р(х)} называется величина

Н(Х) = М [- logp(x)] = - 52 Нж) logp(x).

хех

1.3. Энтропия

19

Можно интерпретировать энтропию как количественную меру априорной неосве-

домленности о том, какое из сообщений будет порождено источником. Часто

говорят, что энтропия является мерой неопределенности. Приведем несколько

свойств энтропии, проясняющих смысл этого понятия и позволяющих оценивать

энтропию без точных вычислений.

Свойство 1.3.1. Н(Х) 0.

Свойство 1.3.2. Я(Х) log |Х|. Равенство имеет место в том и только в том

случае, когда элементы ансамбля X равновероятны.

Свойство 1.3.3. Если для двух ансамблей X и Y распределения вероятностей

представляют собой одинаковые наборы чисел (различающиеся только порядком

следования элементов), то Н(Х) = Н(У).

Свойство 1.3.4. Если ансамбли XuY независимы, то

H(XY)=H(X) + H(Y).

Свойство 1.3.5. Энтропия - выпуклая П функция распределения вероятностей

на элементах ансамбля X.

Свойство 1.3.6. Пусть X = {ж,р(х)} и А С X. Введем ансамбль X' = {х,р'(ж)},

задав распределение вероятностей р'(х) следующим образом:

( р(А)

// ч J ”Г7Г’жеЛ’

р (ж) = < |Л|

( р(х),х ф А.

Тогда Н(Х') Н(Х). Иными словами, «выравнивание» вероятностей элементов

ансамбля приводит к увеличению энтропии.

Свойство 1.3.7. Пусть задан ансамбль X ина множестве его элементов опре-

делена функция д(х). Введем ансамбль Y = {у = д(х)}. Тогда Я(У) Н(Х).

Равенство имеет место тогда и только тогда, когда функция д(х) обратима.

Смысл последнего утверждения состоит в том, что обработка информации не

приводит к увеличению энтропии.

Доказательства свойств 1.3.1, 1.3.3 и 1.3.4 мы оставляем читателю в качестве

очень простых упражнений. Доказательства свойств 1.3.5 и 1.3.6 будут даны

в следующем параграфе. Доказательство свойства 1.3.7 мы отложим до знаком-

ства с понятием условной энтропии (параграф 1.5).

Доказательство свойства 1,3.2. Рассмотрим разность левой и правой частей

доказываемого неравенства:

20

Глава 1. Энтропия дискретных источников

Я(Х) - log |Х|

= - $2 P(®) bg р(х) - р(ж) log | =

хЕХ хЕХ

(с) ( 1 А

* lo8e

= ioge =0-

\sGX । I xEX /

Поясним приведенные выкладки. Переход (а) основан на свойстве нормировки

вероятностей, (Ь) - на свойствах логарифма. Переход (с) использует хорошо

известное неравенство

In Ж X — 1,

эквивалентное неравенству

(1.3)

logrr (я — l)loge.

Нам придется еще не раз воспользоваться этим свойством логарифма, поэтому

остановимся на нем подробнее. Графики функций In х и (х — 1) приведены

на рис. 1.1. Из них видно, что неравенство превращается в равенство только

1.3. Энтропия

21

в одной точке х = 1. Поэтому в нашем случае необходимым и достаточным

условием равенства будет условие р(х) = 1/|Х|, х е X. Последующие переходы

снова используют условие нормировки вероятностей. Итак, разность оказалась

неотрицательной и, следовательно, свойство 1.3.2 доказано. □

Сформулированные выше свойства имеют простую интерпретацию. Достаточно

вспомнить, что энтропия определяет информативность источника или средние

затраты на представление информации в двоичной форме. Рассмотрим, напри-

мер, источник с объемом алфавита 256. При любом распределении вероятностей

на буквах источника одного байта (8 бит) на букву достаточно для хранения

любого из сообщений источника. Свойство 1.3.2 говорит о том, что в предельном

случае, когда все буквы источника равновероятны, энтропия источника как раз

и равна 8 бит.

Предположим теперь, что речь идет о текстовом файле на русском языке. Если

использовать в качестве вероятностей букв их средние частоты появления

в тексте, то, подставив вероятности в формулу для энтропии, получим величину

близкую к 4,5. Это означает, что буква русского текста несет в среднем 4,5 бита, то

есть не следует тратить для ее хранения целый байт. Попробуем обработать файл

каким-либо стандартным архиватором. Окажется, что файл достаточно большого

объема сожмется примерно в 4 раза. Может показаться, что на самом деле энтро-

пия дает плохую оценку затрат на хранение букв источника. Это не совсем

верно. Обратимся к свойству 1.3.4. Из него следует, что затраты на хранение

последовательности букв можно подсчитать как сумму затрат на каждую букву

в том случае, когда буквы независимы. Это условие заведомо не выполняется для

осмысленного текста. Значит, нам необходимо научиться подсчитывать энтро-

пию источников зависимых сообщений. Этим мы займемся позже. Свойство 1.3.5

сыграет свою роль при анализе информационных характеристик источников.

Свойство 1.3.6 подсказывает, почему для одних ансамблей энтропия велика, для

других - мала. Все дело в том, насколько разнятся вероятности, с которыми появ-

ляются буквы. Знать, что некоторые буквы более вероятны, - это все равно что

иметь какую-то информацию еще до того, как буква будет порождена источни-

ком. Нужно только научиться использовать на практике эту априорную инфор-

мацию.

Перейдем к рассмотрению очень простого и очень важного примера - двоичного

ансамбля сообщений.

Пример 1.3.1. Рассмотрим двоичный ансамбль X = {0,1}. Положим р(1) = р,

р(0) = 1 — р = <?. Энтропия этого ансамбля

Я(Х) = -plogp- glogg = р(р). (1.4)

Мы ввели специальное обозначение т?(р) для энтропии двоичного ансамбля,

в котором один из элементов имеет вероятность р. Эта функция будет часто

использоваться. Построим график зависимости т/(р) от р при р е [0,1]. Начнем

с крайних точек р = 0 и р = 1. В обоих случаях имеет место неопределен-

ность. Тем не менее, используя правило Лопиталя, легко вычислить предельные

22

Глава 1. Энтропия дискретных источников

значения т/(р) при р —> 0 и р 1. Получим т/(0) = ??(1) = 0. Далее, заметим,

что т/(р) = ??(1 — р), то есть функция симметрична относительно оси р = 1/2.

Это можно было бы также вывести, опираясь на свойство энтропии 1.3.3. Чтобы

найти экстремальные точки, следует вычислить производную функции ??(р):

7?'(р) = - logp + l°g(l - р)-

Точкой экстремума функции р(р) оказывается точка р = 1 /2. Вычисляя вторую

производную

т?"(р) = ~ loge/p - loge/(l - р) < 0,

убеждаемся в том, что это точка максимума. Этот результат можно было предска-

зать на основе свойства 1.3.2. Кроме того, нетрудно видеть, что вторая производ-

ная строго отрицательна. Отсюда следует, что энтропия двоичного ансамбля -

строго выпуклая вверх функция параметра р. График функции р(р) представлен

на рис. 1.2.

Программисты и инженеры, имеющие дело с двоичной информацией, привыкли

называть битом любой двоичный разряд в записи числа, содержимое двоичной

ячейки памяти или значение двоичного сигнала. Мы теперь знаем, что в терминах

теории информации один бит - максимальное среднее количество информа-

ции, переносимое двоичным сигналом. Если, например, вероятность единицы

равна 0,1, то энтропия двоичного ансамбля равна 0,469, то есть приблизительно

половине бита. Получается, что «инженерный бит» в данном случае в 2 раза

больше «теоретико-информационного бита».

1.4. Выпуклые функции многих переменных

23

1.4. Выпуклые функции многих переменных

Нам предстоит исследовать поведение некоторых функций на множестве X

в зависимости от распределения вероятностей на X. Это означает, что мы будем

иметь дело с функциями нескольких переменных. Поведение функции одной

переменной мы привыкли изучать с помощью производных. По знаку первой

производной мы определяем, возрастает функция в данной точке или убывает.

Равенство нулю первой производной означает, что точка подозрительна на экс-

тремум. Знак второй производной (минус) говорит о выпуклости или (плюс) —

о вогнутости функции в точке и позволяет, в частности, классифицировать точки,

подозрительные на экстремум, как точки минимума, максимума или точки пере-

гиба.

Изучение выпуклости функции многих переменных помогает во многих случаях

судить о поведении функций, в частности, о существовании и единственности

их экстремумов, без выполнения громоздких вычислений.

В теории информации принято различать функции выпуклые вверх и функции

выпуклые вниз. В первом случае для краткости пишут, что функция выпукла П,

а во втором — что она выпукла U.

В следующих определениях мы опираемся в основном на геометрические пред-

ставления о выпуклости, а не на вычисление производных. Прежде всего, рас-

смотрим множество значений аргументов (область определения функции) и вве-

дем для него понятие выпуклости.

Множество аргументов функции запишем в виде вектора. Рассмотрим произ-

вольную функцию /(я?), определенную для всех векторов из некоторого мно-

жества R — {я?}. Само множество R мы считаем подмножеством т-мерного

евклидова пространства векторов с вещественными компонентами. На рис. 1.3

приведены примеры двумерных областей R.

Рис. 1.3. Примеры двумерных областей

Среди этих примеров множеств второе множество невыпуклое, остальные три -

выпуклые. Формальный критерий здесь такой: если для любых двух точек мно-

жества весь отрезок, соединяющий эти точки, принадлежит множеству, то мно-

жество является выпуклым.

Множество вещественных векторов R выпукло, если для любых я?, я?' е R и

любого а е [0,1] вектор у = ах + (1 — а)я/ принадлежит R.

24

Глава 1. Энтропия дискретных источников

В этом определении множество значений вектора у представляет собой одномер-

ную линейную функцию параметра а или, проще говоря, прямую. Эта прямая,

очевидно, проходит через точки х и ж'. Поскольку область изменения пара-

метра а ограничена отрезком [0,1], множество значений вектора у принадлежит

отрезку, соединяющему точки жиж'. Таким образом, формальное определение

в точности соответствует графической интерпретации.

Приведем важный для нас содержательный пример выпуклой области.

ТЕОРЕМА 1.1. Множество вероятностных векторов длины М выпукло.

Доказательство. Напомним, что компоненты вероятностных векторов неотрица-

тельны и сумма компонент равна 1. Будем записывать распределение вероятно-

стей на множестве X = {1,2,..., М} в виде вектора из М элементов. Для двух

распределений вероятностей, р = (pi,... ,рм) и р' = (р'15... ,р^), и параметра

а е [0,1] рассмотрим множество векторов вида

q = ар + (1 - а)р'.

Нужно доказать, что этот вектор тоже стохастический. Все элементы вектора

Q = (<7ь • • • неотрицательны, поскольку в правой части имеем сумму двух

неотрицательных векторов. Сумма компонент вектора q

мм м

$2«< = + (1 - а) = а + 1 - а = 1.

1-—1 I— 1 ®=1

Тем самым утверждение доказано. □

Теперь мы готовы к тому, чтобы конкретизировать понятие выпуклой функции.

Функция /(ж) векторного аргумента х, определенная на выпуклой области Я,

называется выпуклой П на этой области, если для любых as, os' G R и любого

а е [0,1] имеет место неравенство

f(ax + (1 - а)®') > otf(x) + (1 - а)/(ж'). (1.5)

Отметим, что, если в (1.5) возможно равенство при некоторых значениях а е (0,1),

функцию называют нестрого выпуклой. В противном случае она называется строго

выпуклой. Выпуклость области определения функции нужна для того, чтобы

выражение в левой части (1.5) имело смысл.

Определение функции выпуклой U получается из (1.5) изменением знака нера-

венства на противоположный. Мы в дальнейшем рассматриваем только выпук-

лые П функции, считая, что перенос результатов на второй случай не составляет

труда.

Рисунок 1.4 поясняет понятие выпуклой функции многих переменных на при-

мере функции одной переменной. Из элементарных геометрических соображе-

ний следует, что правой части (1.5) при различных значениях а соответствуют

1.4. Выпуклые функции многих переменных

25

точки отрезка, соединяющего точки с координатами (a?i, и (ж2, /(ж2)). Левой

части соответствуют точки на кривой. Из рисунка видно, что

f(axi + (1 - а)^) > af(xi) + (1 - a)f(x2)

и определение выпуклости функции многих переменных хорошо согласуется

с привычным понятием выпуклости функции одной переменной.

Непосредственно из определения, используя метод математической индукции,

легко вывести следующее свойство выпуклых функций.

ТЕОРЕМА 1.2. Пусть f(x) - выпуклая А функция векторного аргумента х, опре-

деленная на выпуклой области R, и пусть константы 0ц,..., &м е [0,1] таковы,

м

что = 1. Тогда для любых х±,..., хм G R

т=1

(М

т=1

М

> 52 a^f(xт)*

т=1

(1.6)

Это свойство имеет следующую важную для дальнейшего применения интерпре-

тацию. Пусть константы ат, использованные в формулировке этого свойства,

означают вероятности соответствующих векторов жт. Тогда суммы в правой и

левой частях (1.6) будут математическими ожиданиями, если считать, что слу-

чайный вектор х принимает значение хт с вероятностью ат. Получаем полезное

неравенство

/(М[®]) >М(/(®)]. (1.7)

Именно это простое неравенство, часто называемое неравенством Йенсена, в даль-

нейшем сократит выкладки, связанные с анализом информационных характе-

ристик алгоритмов кодирования. Однако, чтобы пользоваться им, нужно быть

26

Глава 1. Энтропия дискретных источников

уверенным, что функция выпукла. Поэтому остаток параграфа будет посвящен

выводу признаков выпуклости функций многих переменных.

В формулировках следующих утверждений, вытекающих из определения выпук-

лых функций, предполагается, что все функции определены на одной и той же

выпуклой области.

Свойство 1.4.1. Сумма выпуклых функций выпукла.

Свойство 1.4.2. Произведение выпуклой функции и положительной константы

представляет собой выпуклую функцию.

Прямым следствием этих утверждений является еще одно свойство.

Свойство 1.4.3. Линейная комбинация выпуклых функций с неотрицательными

коэффициентами - выпуклая функция.

Теперь мы знаем, что доказать выпуклость функции многих переменных можно,

представив функцию в виде линейной комбинации других функций, выпуклость

которых доказать легко. Если, например, функция представлена в виде линейной

комбинации функций одной переменной, то анализ составляющих можно выпол-

нить, вычислив производные. Опираясь на эти результаты, докажем выпуклость

энтропии ансамбля как функции распределения вероятностей на множестве его

элементов.

ТЕОРЕМА 1.3. Энтропия Н(р) дискретного ансамбля с распределением вероят-

ностей р является выпуклой п функцией аргумента р.

Доказательство. Прежде всего, заметим, что постановка вопроса о выпуклости

энтропии корректна, поскольку ее область определения выпукла в соответствии

с доказанной выше теоремой 1.1. По определению энтропии

м м

Н(р) = “ 52 PrnlogPm = 52 /”»(₽)•

т=1 7П=1

Рассмотрим слагаемые Каждое из них представляет собой функцию одной

переменной. Вторая производная этой функции равна — (loge)/pm и, следова-

тельно, отрицательна при всех рт е (0,1). Таким образом, энтропия выпукла

в силу свойства 1.4.3. Тем самым теорема доказана. □

Заметим, что слагаемые fm(p) в (1.8) - строго выпуклые функции. Следова-

тельно, энтропия также строго выпукла.

В заключение параграфа мы приведем пример применения свойств выпуклых

функций как инструмента исследования свойств информационных мер. Докажем

свойство энтропии 1.3.6.

Доказательство свойства 1.3.6. Пусть имеется ансамбль X, |Х| = М. Запи-

шем вероятности букв в виде вектора р = (pi,... ,рм)« Для энтропии ансамбля

1.5. Условная энтропия

27

будем использовать обозначение Н(р). Докажем, частный случай утверждения,

а именно, что выравнивание вероятностей первого и второго элементов множе-

ства X приводит к увеличению энтропии. Обобщение на случай произвольного

подмножества А С X оставим читателю в качестве упражнения. Обозначим

Р = ((pi + Рг)/2, (pi +Р2)/2, рз, • • •, Рм). Нужно доказать неравенство

Н(р) > Щр). (1.9)

Для этого введем обозначения

Р'=Р = (Р1,Р2,РЗ,---,Рм),

Р" = (Р2,Р1,РЗ,---,Рм)-

Заметим, что по свойству энтропии 1.3.3 два распределения имеют одинаковую

энтропию, то есть Н(р') = Н(р") = Н(р). Справедливо тождество р = (р' +р")/2.

Из выпуклости энтропии следует, что

Я(р) = н > |я(р')+ IW') = Н^- °

1.5. Условная энтропия

Как уже отмечалось, для эффективного кодирования информации необходимо

учитывать статистическую зависимость сообщений. Наша ближайшая цель -

научиться подсчитывать информационные характеристики последовательностей

зависимых сообщений. Начнем с последовательности, состоящей из двух сооб-

щений.

Рассмотрим ансамбли X = {ж} и Y = {у} и их произведение XY = {(ж, р),р(ж, р)}.

Для любого фиксированного у е Y можно построить условное распределение

вероятностей р(ж|р) на множестве X и для каждого х е X подсчитать собствен-

ную информацию

/(ф) = ~logp(rr|p),

которую называют условной собственной информацией сообщения х при фикси-

рованном у.

Ранее мы назвали энтропией ансамбля X среднюю информацию сообщений х е X.

Аналогично, усреднив условную информацию I(x\y) по х е X, получим величину

н(х\у) = - 52 1о&р(х\уУ (1Л°)

хех

называемую условной энтропией X при фиксированном у е Y. Заметим, что

в определении (1.10) имеется неопределенность в случае, когда р(х\у) = 0. Выше,

в параграфе 1.3, отмечалось, что выражение вида z log z стремится к нулю при

z —> 0, и на этом основании мы считали равными 0 все слагаемые энтропии,

соответствующие буквам, вероятность которых равна 0. Точно так же в (1.10)

мы считаем равными нулю слагаемые, для которых р(ж|?/) = 0.

28

Глава 1. Энтропия дискретных источников

Вновь введенная энтропия Н(Х\у) - случайная величина, поскольку она зави-

сит от случайной переменной у. Чтобы получить неслучайную информационную

характеристику пары вероятностных ансамблей, нужно выполнить усреднение

в (1.10) по всем значениям у. Величина

H(X\Y) = - 22

xtXyEY

называется условной энтропией ансамбля X при фиксированном ансамбле Y. Отме-

тим ряд свойств условной энтропии.

Свойство 1.5.1. Я(Х|У) 0.

Свойство 1.5.2. Я(Х|У) < Н(Х), причем равенство имеет место в том и толь-

ко в том случае, когда ансамбли XuY независимы.

Свойство 1.5.3. Я(ХУ) = Я(Х) + H(Y\X) = H(Y) + Я(Х|У).

Свойство 1.5.4. Я(Хх...Хп) = Я(Хг) + Я(Х2|Х1) 4- Я(Х3р№) + • • • +

+ Я(Хп|Х1,...,Хп-1).

Свойство 1.5.5. H(XIYZ) < H(X\Y), причем равенство имеет место в том и

только в том случае, когда ансамбли X и Z условно независимы при всех у € У.

п

Свойство 1.5.6. H(Xi... Хп) причем равенство возможно только

г=1

в случае совместной независимости ансамблей Xi,..., Хп.

Свойство 1.5.1 доказывается так же, как свойство энтропии 1.3.1. Мы приведем

два доказательства свойства 1.5.2. Первое основано на относительно простых

выкладках и использует неравенство (1.3). Другое доказательство приводится

в качестве примера использования выпуклости энтропии.

Доказательство свойства 1.5.2. По аналогии с доказательством свойства энтро-

пии 1.3.2

Я(Х|У)-Я(Х) = -^^p(x,y)logp(x\y) +

xeXyeY

+ 52 52 ^х' у"> log^x) = 52 52 у) log J©

xeXy^Y xeXyeY

xeXy^Y 7

= 152 52 Hj/W)- 52 52 p(x>y))loge=°-

xeXyeY J

1.5. Условная энтропия

29

Это же свойство можно вывести из свойства выпуклости энтропии. Поскольку

энтропия ансамбля зависит только от распределения вероятностей, вместо выра-

жения Я(Х) будем писать Я(рх), где рх означает записанное в виде вектора

распределение вероятностей {р(ж)}. Тогда

Я(Х|У) (=> Му[я(рх|в)]<

? я(Му[рх|у]) =

= Н(рх) = Н(Х),

где Рх\у ~ условное распределение на X при фиксированном у, переход (а)

основан на определении условной энтропии, неравенство (Ь) - на выпуклости

энтропии, следующее затем равенство (с) основано на формуле полной вероят-

ности

Му [р(а:|у)] = ^р(х\у)р(у) = р(х). g

Доказательство свойств 1.5.3 и 1.5.4УПо формуле перемножения вероятностей

р(ж,у) = р(х)р(у\х) = р(у)р(х\у),

р(ж1,..., хп) = р(х1)р(х2\х1)... p(a?nki,...,

Обе стороны этих тождеств нужно прологарифмировать, а затем усреднить по

всем случайным переменным. □

Доказательство свойства 1.5.5. Рассмотрим ансамбль XYZ = {(ж, у, z),p(x, у, z)}.

При каждом у е Y определены условные распределения p(x,z\y) и р(х\у). Для

этих распределений запишем энтропии

Я(Х|у,2) = MXZ|J/[-logp(x|y2)],

Я(Х|у) = MX|s[-logp(x|y)].

По свойству 1.5.2

H(X\y,Z)<H(X\y).

После усреднения по всем у получим требуемое неравенство. □

Из свойств 1.5.1-1.5.5 следует 1.5.6.

Обсудим «физический смысл» сформулированных свойств условной энтропии.

Свойство 1.5.2 устанавливает, что условная энтропия ансамбля не превышает его

безусловной энтропии. Свойство 1.5.5 усиливает это утверждение. Из него сле-

дует, что условная энтропия не увеличивается с увеличением числа условий. Оба

эти свойства неудивительны, они отражают тот факт, что дополнительная инфор-

мация об ансамбле X, содержащаяся в сообщениях других ансамблей, в сред-

нем уменьшает информативность (неопределенность) ансамбля X. Замечание

«в среднем» здесь очень важно, поскольку неравенство

Н(Х\у) Я(Х),

вообще говоря, неверно.

30

Глава 1. Энтропия дискретных источников

Применим выявленные свойства условной энтропии для доказательства свой-

ства энтропии 1.3.7, устанавливающего невозрастание энтропии при обработке

информации.

Доказательство свойства 1.3.7. Имеем ансамбль X = {х,р(х)}> определенную

на нем функцию д(х) и ансамбль Y = {у = р(ж), х е X}. Нужно доказать, что

Я(У) ^Я(Х). (1.11)

По свойствам энтропии

Я(ХУ) = Я(Х|У) +Я(У) = Я(У|Х) +Я(Х). (1.12)

>0 =о

Поскольку значения д(х) однозначно определены при заданном ж, имеем

H(Y\X) = 0. В то же время Я(Х|У) 0. С учетом этих обстоятельств из (1.12)

следует (1.11). □

Напомним, что вычисление энтропии - это вычисление затрат на передачу или

хранение букв источника. Свойства условной энтропии подсказывают, что при

передаче буквы Xn+i следует использовать то обстоятельство, что предыдущие

буквы Xi, ..., Хп уже известны принимающей стороне. Это позволит вместо

Я(Хп+1) бит потратить меньшее количество Я(Хп+1|Х1,... ,Хп) бит. В то же

время свойство 1.5.6 указывает другой подход к экономному кодированию. Из

этого неравенства следует, что буквы перед кодированием имеет смысл объ-

единять в блоки и эти блоки рассматривать как буквы нового «расширенного»

источника. При этом затраты будут меньше, чем при независимом кодировании

букв. Какой из двух подходов эффективнее?

Ниже мы дадим более точную количественную характеристику этих двух подхо-

дов, но перед этим вспомним некоторые определения из теории вероятностей.

1.6. Дискретные случайные

последовательности. Цепи Маркова

Вместо отдельных ансамблей и произведений конечного числа ансамблей мы

будем рассматривать теперь случайные последовательности из произвольного

числа событий. Если элементы случайной последовательности - вещественные

числа, то такие последовательности называются случайными процессами.

Номер элемента в последовательности трактуется как момент времени, в который

появилось данное значение. Множество значений времени может быть непре-

рывным либо дискретным, и множество значений случайной последовательно-

сти также может быть непрерывным либо дискретным. Сейчас нас интересуют

только дискретные процессы дискретного времени.

\

Случайный процесс xi, х2, ...со значениями Хг G X, i = 1,2,..., задан, если

для любых п указан способ вычисления совместных распределений вероятностей

1.6. Цепи Маркова

31

Проще всего задать случайный процесс, предположив, что его значения в раз-

личные моменты времени независимы и одинаково распределены. Тогда

п

' 1=1

где p(xi) - вероятность появления xi е X в момент времени г. Для описания

такого процесса достаточно указать вероятности р(х) для всех х е X (всего |Х|-1

вероятностей).

Описание более сложных моделей процессов будет громоздким, если не сделать

упрощающих предположений. Нам не обойтись без предположения о стационар-

ности.

Процесс называется стационарным, если для любых п и t имеет место равенство

p(Xi,.. . , Жп) = pfa+t, • • • , ^n+t),

в котором подразумевается, что Xi = х^и г = 1, ..., п. Иными словами, случай-

ный процесс стационарен, если вероятность любой последовательности не изме-

няется при ее сдвиге во времени (не зависит от положения последовательности

на оси времени).

Числовые характеристики (в частности, математическое ожидание) стационар-

ных процессов не зависят от времени. Рассматривая стационарные процессы,

мы можем вычислять независящие от времени информационные характеристики

случайных процессов.

Мы уже рассмотрели один пример стационарного процесса - процесс, значения

которого независимы и одинаково распределены. Источник, порождающий такой

процесс, называют дискретным постоянным источником (ДПИ).

Простейшей моделью источника, порождающего зависимые сообщения, является

марковский источник.

Случайный процесс х±, х2, ...называют цепью Маркова связности з, если для

любых п и для любых х = (®i,..., хп) е Хп справедливы соотношения

р(х) =р(ж1,...,жв)р(жв+1|ж1,...,а?в)р(жв+2|ж2...жв+1) X ••• х

Хр(жп |жп__в, . • • , Хп—1 )•

Иными словами, мы называем марковским процессом связности s такой процесс,

для которого при п > 8

р(хп |^1» • • • , Хп— 1) = р(жп|жп_з, . . . , Хп_ 1), ‘

то есть условная вероятность текущего значения при известных предшествую-

щих з не зависит от всех других предшествующих значений.

Значение марковского процесса xt в момент времени t принято называть состо-

янием в момент t Описание марковского процесса задается начальным распреде-

лением вероятностей на последовательностях из первых з значений (состояний)

32

Глава 1. Энтропия дискретных источников

и условными вероятностями вида р(хп\хп_8,..., жп_1) для всевозможных после-

довательностей (хп-з,... ,жп). Если указанные условные вероятности не изме-

няются при сдвиге последовательностей (жп_в,... ,жп) во времени, марковская

цепь называется однородной.

Однородная марковская цепь связности s = 1 называется простой цепью Мар-

кова. Для описания простой цепи Маркова с множеством состояний X =

= {0,1,...,М-1} достаточно указать начальное распределение вероятностей

{р(ж1), xi е X} и условные вероятности

TTij = P(xt = jfxt-i = i), i, j = 0,..., M - 1,

называемые переходными вероятностями цепи Маркова.

Переходные вероятности удобно записывать в виде квадратной матрицы размер-

ности М х М

п = Я"00 7Г10 7Г01 7Гц Я0,М-1

. ТГМ-1,0 ТГМ-1,1 • •* 7ГМ-1,М-1 _

называемой матрицей переходных вероятностей. Эта матрица - стохастическая

(неотрицательная, сумма элементов каждой строки равна 1).

Обозначим через pt стохастический вектор, компоненты которого - вероятности

состояний цепи Маркова в момент времени t, то есть pt — . ,Pt(M - 1)),

где pt (г) есть вероятность состояния i в момент времени Л i = 0, ..., М — 1. Из

формулы полной вероятности следует, что

М-1

Pt+1G) = Р^№ц

3=0

или в матричной форме

Pt+i = (1*13)

Отсюда для произвольного числа шагов п получаем

Pt+n = Ptnn-

Значит, вероятности перехода за п шагов могут быть вычислены как элементы

матрицы Пп.

Из (1.13) видим, что распределение вероятностей в момент времени t зависит от

величины t и от начального распределения рг. Отсюда следует, что в общем слу-

чае рассматриваемый случайный процесс нестационарен. Предположим, однако,

что существует стохастический вектор р, удовлетворяющий уравнению

р = рП.

(1.14)

1.6. Цепи Маркова

J33

Положим рг = р. Тогда, воспользовавшись (1.13), получим р2 = р и в конечном

итоге pt = р при всех t. Таким образом, однородная марковская цепь стацио-

нарна, если в качестве начального распределения выбрано решение уравнения

(1.14).

Стохастический вектор р, удовлетворяющий уравнению (1.14), называется ста-

ционарным распределением для цепи Маркова, задаваемой матрицей переходных

вероятностей П.

Финальным распределением вероятностей называют вектор

Poo = lira pt = lim р^*, (1.15)

с—>оо t—>оо

(если указанный предел существует).

Из этого определения следует, что финальное распределение - распределение

вероятностей в момент времени t. бесконечно далекий от начального момента

времени t = 1. Было бы естественно ожидать, что с течением времени зависи-

мость от начального распределения рх ослабевает и что р^ не зависит от рР

Оно не зависит также и от времени. Таким образом, распределение р^ тоже

(как и р), в некотором смысле, стационарное распределение. Как же соотносятся

между собой Роо и р?

Оказывается, для широкого класса простых цепей Маркова предел в (1.15) не

зависит от начального распределения рг и равен единственному решению урав-

нения (1.14), то есть р^ = р. Такие цепи называют эргодическими.

Как найти по матрице П, эргодична ли соответствующая цепь Маркова? Ответ

на этот вопрос заведомо положительный, если все элементы матрицы П поло-

жительны (не равны нулю). Более точное (но и сложнее проверяемое) усло-

вие состоит в том, что должна существовать некоторая положительная степень

по матрицы П такая, что все элементы матрицы Пп положительны при любых

п По.

Чтобы сформулировать необходимое и достаточное условие эргодичности, при-

дется ввести несколько определений.

Состояние цепи i достижимо из состояния J, если для некоторого п вероятность

перехода из состояния j в состояние г за п шагов положительна. Множество

состояний С называется замкнутым, если никакое состояние вне С не может

быть достигнуто из состояния, входящего в С.

Цепь называется неприводимой, если в ней содержится не больше одного замкну-

того множества. Цепь Маркова неприводима, в частности, тогда, когда все ее

состояния достижимы друг из друга.

Состояние i называется периодическим, если существует такое t > 1, что вероят-

ность перехода из г в г за п шагов равна нулю при всех п, не кратных t. Цепь, не

содержащая периодических состояний, называется непериодической.

34

Глава 1. Энтропия дискретных источников

В этих терминах мы наконец можем точно определить класс эргодических цепей

Маркова.

ТЕОРЕМА 1.4. Непериодическая неприводимая цепь Маркова эргодична.

С понятием эргодичности применительно к более широкому классу процессов,

чем цепи Маркова, мы познакомимся подробнее в связи с кодированием источ-

ников.

1.7. Энтропия на сообщение дискретного

стационарного источника

Рассмотрим произвольный дискретный стационарный источник, порождающий

последовательность (xi, ж2,..., xt,...), xt е Xt = X, Из предположения о стаци-

онарности следует, что распределение вероятностей для буквы xt, порождаемой

в момент времени t, не зависит от t Следовательно, энтропия этого распре-

деления Я(Х*) = Я(Х) также не зависит от времени. Назовем ее одномерной

энтропией источника (или соответствующего случайного процесса). Обозначим

ее как Я1(Х).

Как уже было отмечено, величина Я1(Х) не определяет полностью информаци-

онные характеристики процесса, поскольку не учитывает зависимости букв.

Рассмотрим последовательность из п последовательных букв источника х =

= (®i,..., хп) е Xi%2 .• -Хп = Хп. Для стационарного процесса энтропия рас-

пределения вероятностей на таких блоках Н(Х±... Хп) = Я(ХП) не зависит от

расположения блока во времени, ее называют п-мерной энтропией источника.

Величина Я(ХП) определяет среднее количество информации в последователь-

ности из п букв. Нормированную величину

называют энтропией на букву последовательности длины п. Интуиция подсказы-

вает, что значения ЯП(Х) при больших п могли бы служить адекватной мерой

информативности источника.

Другой подход к измерению информации, порождаемой произвольным стацио-

нарным источником, состоит в том, что при передаче буквы хп все предыдущие

буквы ^1,..., xn-i можно считать известными декодеру. Среднее количество под-

лежащей передаче информации об хп определяется величиной условной энтро-

пии Я(ХП|Х1,... ,Xn-i). В силу стационарности конкретные значения индек-

сов не играют роли, важна лишь длина предыстории. Поэтому исцользуется

обозначение

н(хп\хъ..., хп^1) = ярсрр-1).

Следующая теорема устанавливает некоторые свойства двух информационных

мер ЯП(Х) и Я(Х|ХП“1) для стационарных источников.

1.7. Энтропия на сообщение

35

ТЕОРЕМА 1.5. Для дискретного стационарного источника

А. Н(Х^Хп) не возрастает с увеличением п.

В. Нп(Х) не возрастает с увеличением п.

с. нп(х) > яр^х”-1).

D. Пт ЯП(Х) = lira Н(Х\Хп).

п—*оо п—>оо

Доказательство. Утверждение А следует из невозрастания энтропии с увеличе-

нием числа условий (свойство 1.5.5).

Из свойства 1.5.4 и стационарности источника имеем

Я(ХП) = Н(Х) + Я(Х|Хх) + • • • +

Заметим, что в правой части п слагаемых, из которых последнее - наименьшее

(в силу свойств 1.5.2 и 1.5.5). Поделив обе части на п, убеждаемся в справедли-

вости утверждения С. ,

Чтобы убедиться в справедливости утверждения В, выполним преобразования

Я(Х"+1) (=} Я(Хх...ХпХп+х) =

= Я(Хх... Хп) + Я(Х„+х |Хх,..., Хп) =

= Я(ХП) + Н(Х\Хп) <

(d)

< Н(Хп) + Я(Х|ХП-1) <

(е)

< Я(Х") + Я„(Х) =

= (п + 1)Яп(Х).

В этой цепочке переход (а) использует предположение о стационарности, (Ь) -

свойство условной энтропии, (с) вновь использует стационарность, a (d) и (е)

опираются на уже доказанные утверждения Л и С. Наконец, (f) следует из опре-

деления величины Нп(Х). Если теперь поделить правую и левую части на (п+1),

убеждаемся в справедливости утверждения В.

Перейдем к доказательству последнего утверждения. Прежде всего отметим, что

последовательности Нп(Х) и Н(Х\Хп) не возрастают и ограничены снизу

(поскольку неотрицательны). Значит, оба предела существуют. Из утверждения

С следует, что

lim ЯП(Х) > lim Н(Х\Хп). (1.16)

п—>оо п—>оо

36

Глава 1. Энтропия дискретных источников

В то же время, при любых натуральных т < п имеют место соотношения

Я(Х”) = Я(Хх...Хп) =

= Я(Х1... Хп) + Я(Хт+1 ...Хп\Х1,...,Хт) =

= тНп(X) + Н(Хт+1 |Хх,..., Хт) + ...

+Я(Хп|Х1,...,Х„_1)<

(с)

тВД + (п - т)Я(Х|Хт).

Здесь использованы: в (а) и (Ъ) - свойства условной энтропии, в (с) - стационар-

ность источника и невозрастание последовательности Н(Х\Хт) с увеличением

числа условий т. Поделив обе части полученного неравенства на п, перейдем

к пределу при п ос. Получим неравенство

lim ЯП(Х) Я(Х|Хт),

п—>оо

справедливое при любых т. Устремляя т к бесконечности, получаем

lim ЯП(Х) lim Я(Х|ХГО). (1.17)

п—>оо т—->оо

Из (1.16) и (1.17) вытекает доказываемое утверждение. □

Введем обозначения

Яоо(Х) = lim ЯП(Х), Я(Х|Х°°) = lim ЩХ\Хп).

п—>оо п—>оо

Основной результат теоремы состоит в том, что H^fX) = Н(Х\Х°°). В даль-

нейшем, изучая конструктивные методы кодирования, мы убедимся в том, что

именно эта величина определяет минимально возможные удельные затраты бит

на передачу одной буквы стационарного источника.

По сути, мы рассмотрели два подхода к анализу информативности стационарного

источника:

► введение расширенного алфавита, буквами которого служат блоки из п сим-

волов источника;

► учет зависимости текущей буквы от п предшествующих букв.

Несмотря на то что при каждом конкретном п второй подход дает более оптими-

стические оценки затрат на передачу или хранение информации (утверждение

0, в пределе (с увеличением параметра п) оба подхода становятся эквивалент-

ными.

Рассмотрим поведение последовательностей ЯП(Х) и Н(Х\Хп) для двух про-

стых моделей дискретных источников. Возможно, это сделает более понятными

и естественными сформулированные выше фундаментальные утверждения.

Пример 1.7.1. Энтропия на сообщение дискретного постоянного источника. Дис-

кретным постоянным источником мы назвали дискретный стационарный источ-

ник без памяти. По свойствам энтропии для источника без памяти имеем

1.7. Энтропия на сообщение

37

Я(Х1.. .Хп) = Я(Хх) +... + Я(ХП).

Н(Хп) = пН(Х).

Поделив обе стороны тождества на п, получим, что при всех п справедливо

равенство

ЯП(Х) = Я(Х)

и, следовательно,

Яоо(Х) = Я(Х).

Таким образом, энтропия на сообщение дискретного постоянного источника

в точности равна его одномерной энтропии. К тому же результату можно было

прийти с другой стороны. В силу стационарности и отсутствия зависимости

между сообщениями

Н(Х\Хп) = Я(Хп+1|Х!,..., Хп) = Я(Х),

следовательно,

Я(Х|Х°°) = Я(Х).

Таким образом, для рассматриваемой модели анализ информационных харак-

теристик сводится к подсчету энтропии одномерного распределения. Отсюда

совсем не следует, что при кодировании источников независимых сообщений

нужно кодировать каждую букву независимо от других.

Пример 1.7.2. Энтропия на сообщение марковского источника. Для стационар-

ного источника, описываемого моделью цепи Маркова связности з, можем запи-

Я(Х|Х") = Я(Х„+1|ХЪ... ,Хп) =

= Я(Хп+1|Хп_8+1,...,Хп) = Я(Х|Хв).

Правая часть не зависит от п, значит,

Я(Х|Х°°) = Я(Х|Х8).

Рассмотрим другой подход. Используя стационарность и свойства условной энтро-

пии, запишем

Я(ХП) = Я(Х,... XSXS+1 ...Хп) =

= Н(Хг... Х8) + Я(Х8+1... ХП|ХЪ..., Х8). (1.18)

Из

Я(Х8+1 ...Xn\Xlt...,Xa) = Я(Х8+1|ХЪ..., Х8)+

+Я(Х8+2|Х1,..., Х8+1) + • • • + Я(ХП|Х1,... ,Х„_1),

учитывая марковость и стационарность, получаем

Я(Х8+1... Xn|Xi,...,Х8) = (п - з)Я(Х|Хв).

Теперь (1.18) принимает вид

Я(ХП) = зЯ8(Х) + (п - з)Я(Х|Хв). (1.19)

Теперь можно поделить обе части на п и устремить п к бесконечности. Резуль-

татом будет ожидаемое равенство

Яоо(Х) = Я(Х|Х®).

38

Глава 1. Энтропия дискретных источников

Поучительно записать (1.19) в виде

о

ЯП(Х) = Н(Х\Х°) + -(ЯДХ) - яда8)) =

п

Q

= яда”) +-(я8(х) - яда8)).

Отсюда хорошо видно, какова разница между ЯП(Х) и Н(Х\Хп). При разбиении

последовательности букв на блоки длиной п мы получаем среднюю энтропию на

сообщение немного большую, чем минимальная достижимая величина Н(Х|Xs).

«Потери» или, точнее сказать, дополнительные затраты связаны с «забвением»

тех s букв, которые предшествовали рассматриваемому блоку.

1.8. Равномерное кодирование дискретного

источника. Постановка задачи

Теперь, когда мы знаем теоретическую характеристику информационной про-

изводительности источника, можно было бы перейти к решению практической

задачи сжатия информации. Однако в данном параграфе мы рассмотрим метод

равномерного кодирования, который не имеет почти никакого практического зна-

чения. Более того, он, по сути, не является сжатием информации без потерь. Тем

не менее изучение равномерного кодирования представляется необходимым по

двум причинам. Во-первых, станет понятнее, почему энтропия совпадает с пре-

дельно достижимой скоростью передачи (хранения) информации (эта скорость

называется скоростью создания информации источником). Во-вторых, на этом

примере мы познакомимся с традиционным для теории информации способом

формулировки теоретических результатов - доказательством прямой и обратной

теорем кодирования.

При равномерном кодировании последовательность порождаемых источником

сообщений а?1, **•» xi Е X, i = 1, 2, ...,. разбивается на блоки одинаковой

длины X. Каждый такой блок кодируется независимо от других.

Для кодирования используется некоторый алфавит А = {а}, называемым кодо-

вым, элементы алфавита называют кодовыми символами. Мы ограничимся рас-

смотрением двоичных кодов, то есть кодов над алфавитом А = {0,1}.

Равномерным кодом длины п называется любое подмножество С множества Ап,

то есть любое подмножество множества последовательностей длины п. Элементы

кода С называют кодовыми словами. Мощность кода |С| - это количество кодо-

вых слов в коде С.

Скоростью равномерного кода называется величина

Я = (бит / букву источника), (1.20)

где [а] обозначает округление числа а вверх до ближайшего целого.

1.8. Равномерное кодирование дискретного источника

39

Наиболее важным частным случаем равномерного кода является множество всех

последовательностей длины п, то есть С = Ап = {0,1}п. При этом скорость кода

R = (бит / букву источника).

Кодирование состоит в том, что каждый блок из N символов источника заме-

няется на п двоичных символов, записываемых в запоминающее устройство или

передаваемых по каналу связи. Таким образом, скорость кода - это удельные

затраты двоичных символов (битов) на передачу одной буквы источника.

В общем случае работа кодера (алгоритм кодирования) описывается отображе-

нием множества XN на множество слов кода С. Декодирование задается отоб-

ражением С на XN. Если оба отображения взаимно однозначные, то на выходе

декодера можно будет получить точную копию передаваемой последовательно-

сти. Взаимно однозначное кодирование возможно только тогда, когда

|X|N |С| (1.21)

или

fl^log|X|>H(X).

Следовательно, если буквы источника не равновероятны (Н(Х) < log |Х|), то

скорость кода окажется заведомо больше энтропии источника.

Рассмотрим теперь ситуацию, когда условие (1.21) не выполнено. Тогда число

кодовых слов недостаточно для того, чтобы сопоставить каждой последователь-

ности источника свое кодовое слово. Для некоторых последовательностей сооб-

щений не найдется кодового слова, по которому декодер смог бы однозначно

восстановить переданную информацию. В общем виде процесс кодирования и

декодирования можно описать следующим образом.

Выделим в XN подмножество Т такое, что \Т\ = |С|, и каждой последова-

тельности из множества Т сопоставим индивидуальное кодовое слово. Множе-

ство Т мы будем называть множеством однозначно кодируемых последовательно-

стей. Остальным последовательностям из XN сопоставим произвольные кодо-

вые слова (например, всем последовательностям из Тс сопоставим одно и то

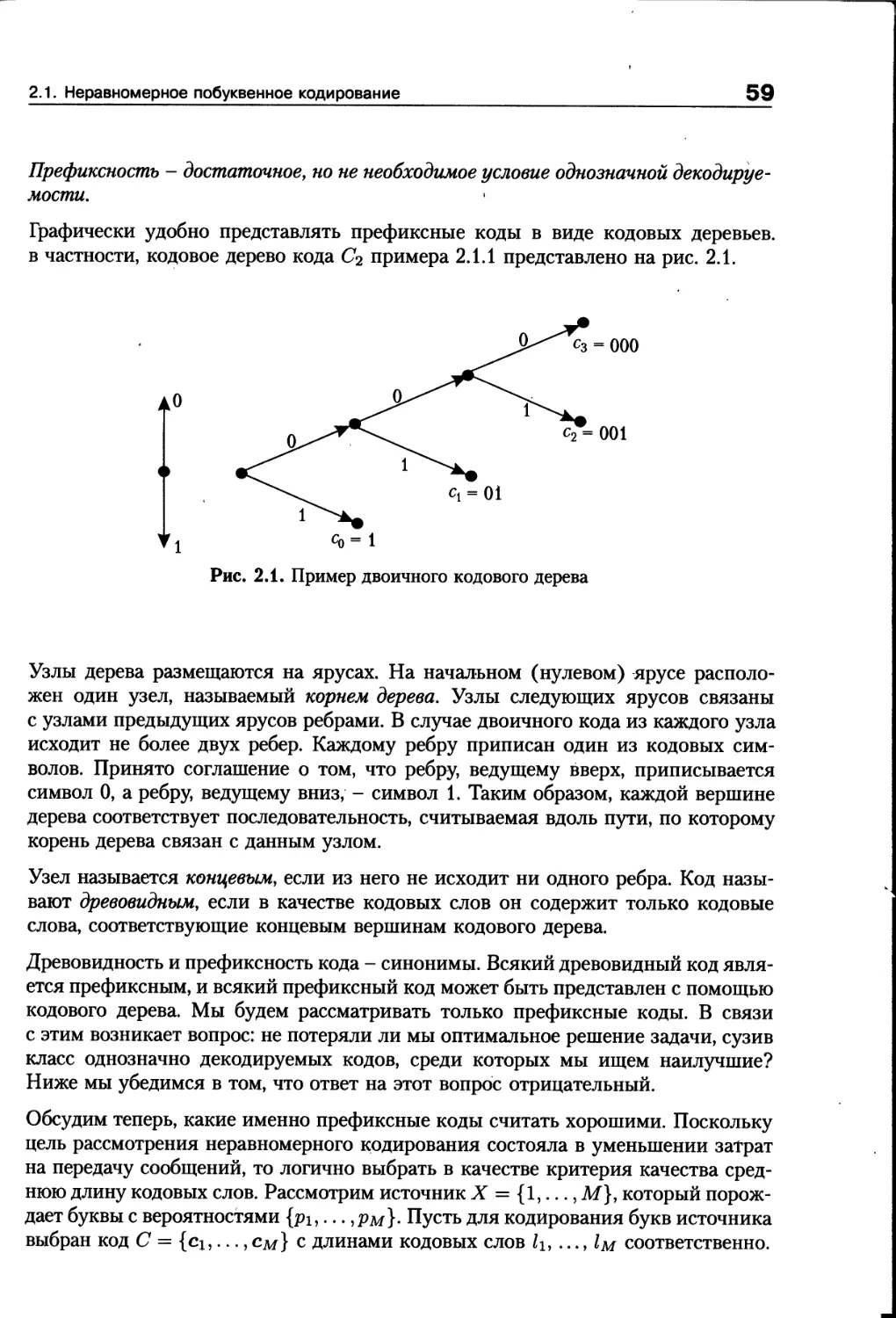

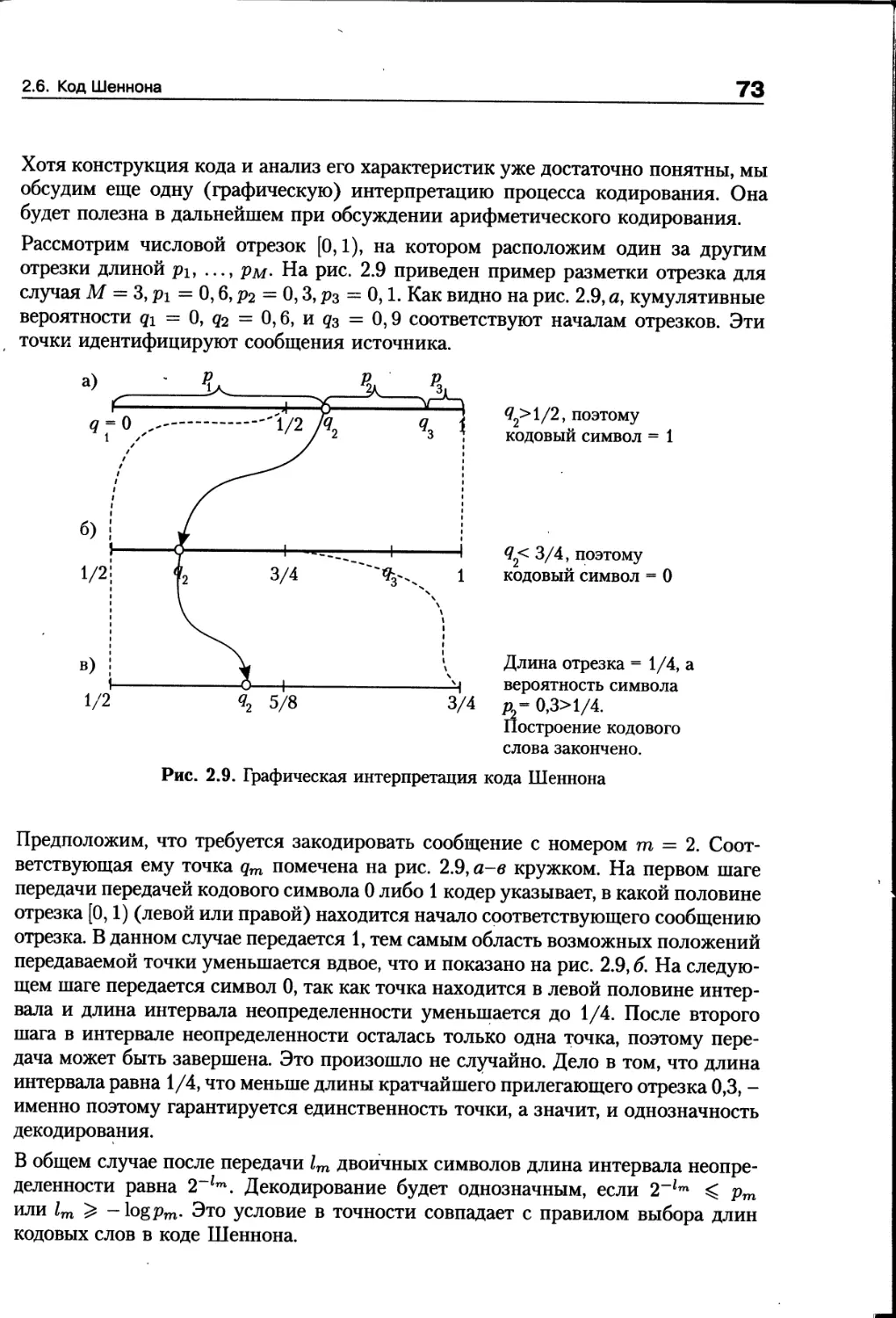

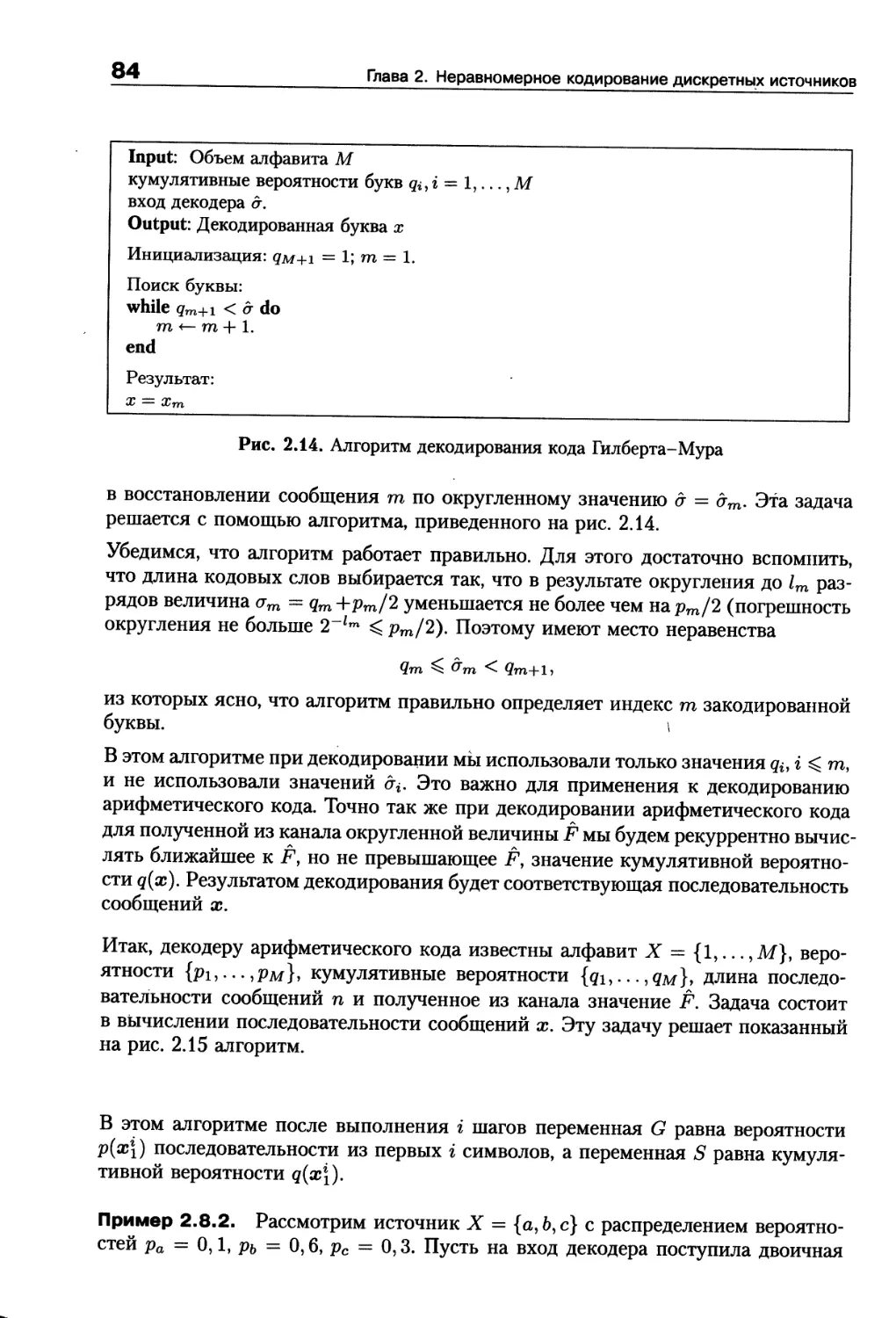

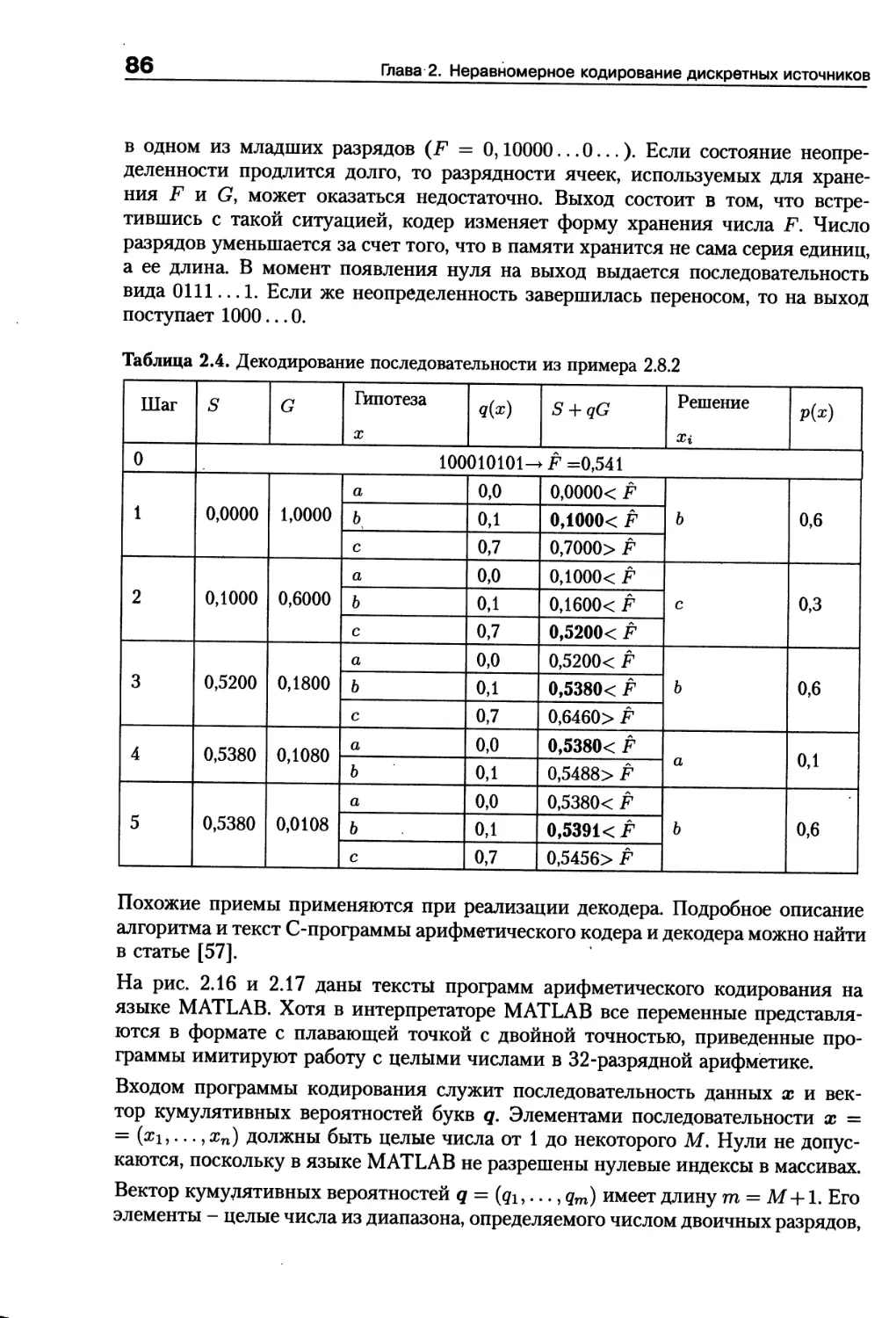

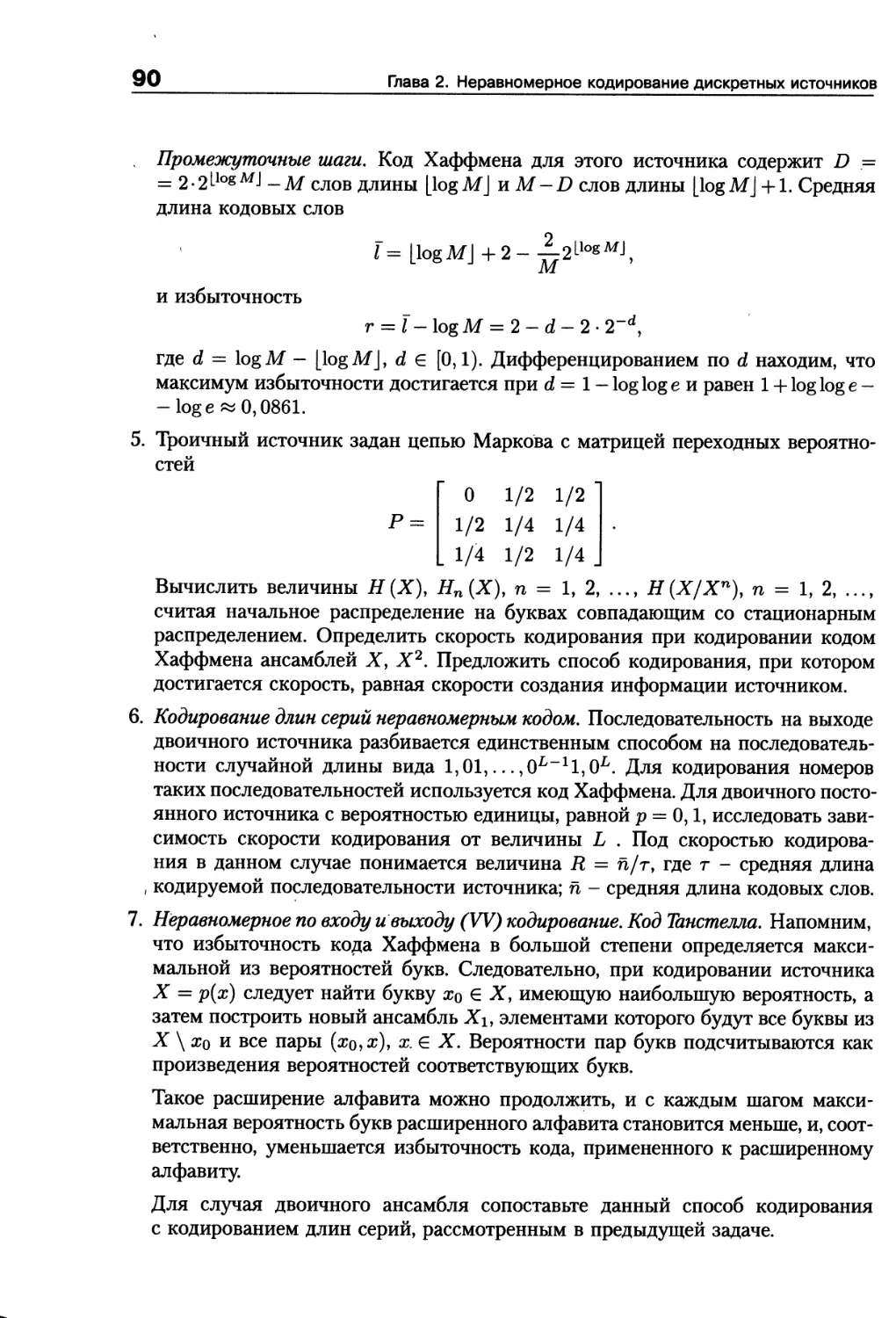

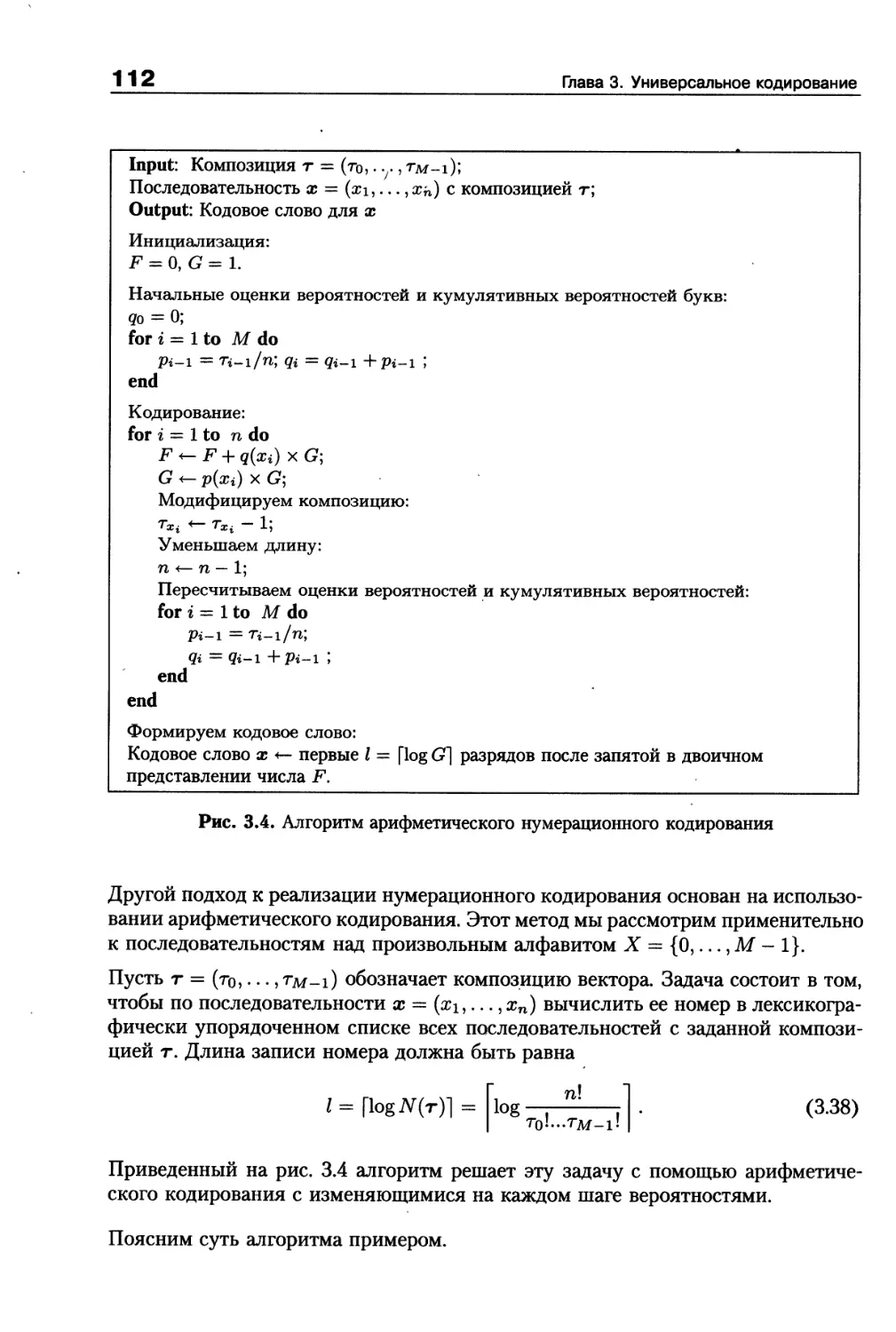

же кодовое слово). Декодер при получении некоторого кодового слова с е С