Текст

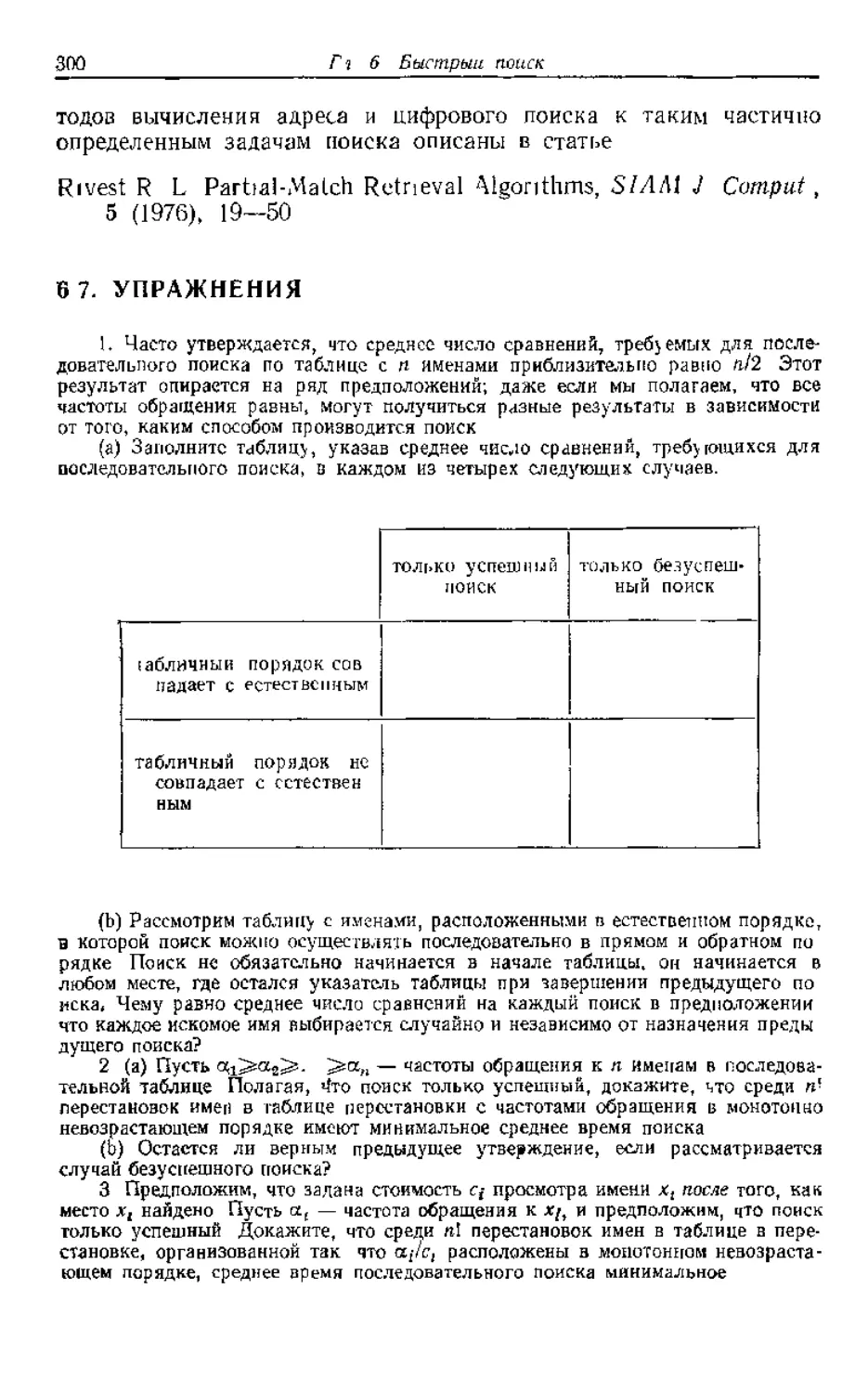

Э. РЕЙНГОЛЬД. Ю. НИВЕРГЕЛЬТ.НДЕО

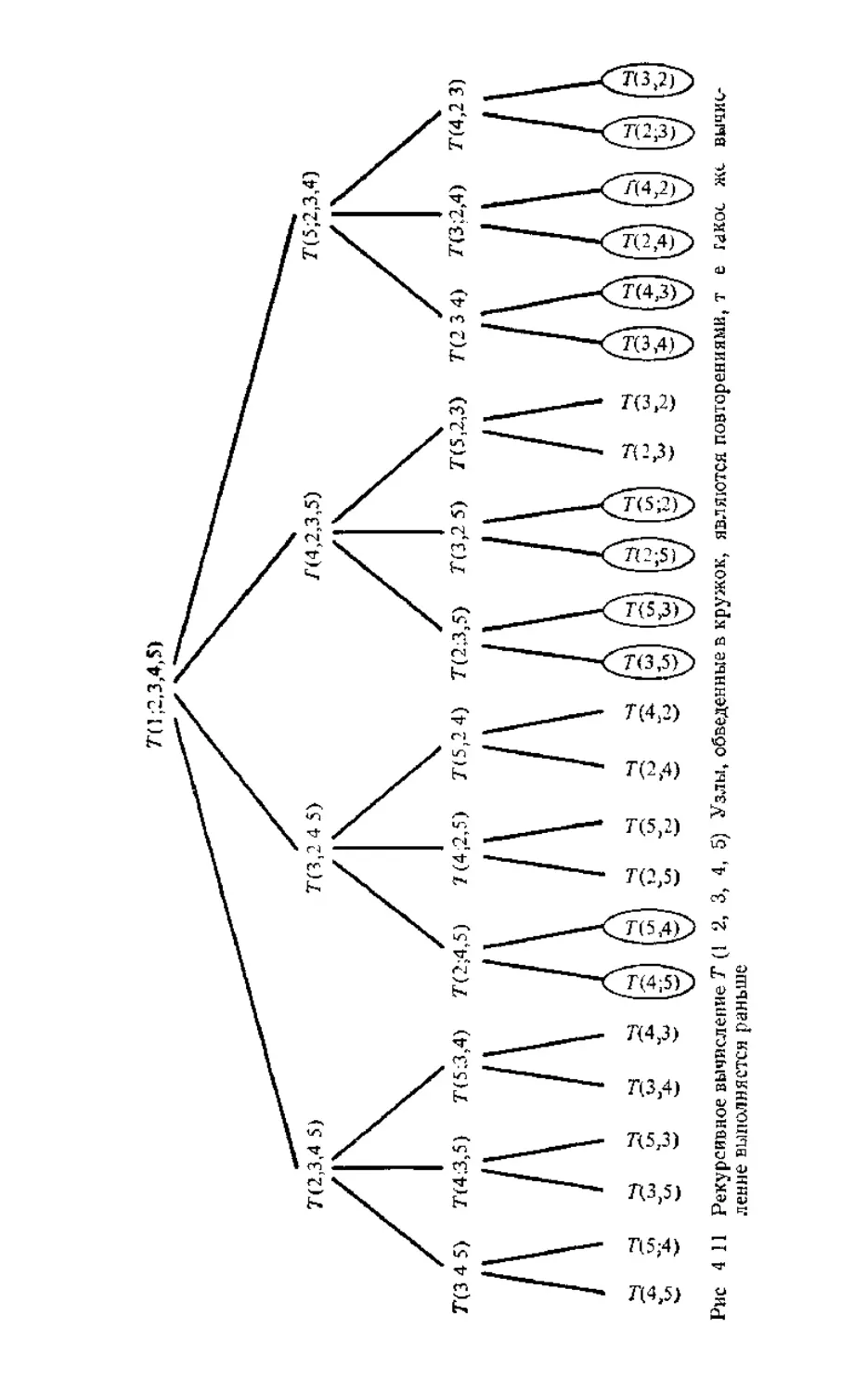

КОМБИНАТОРНЫЕ

АЛГОРИТМЫ

ТЕОРИЯ И ПРАКТИКА

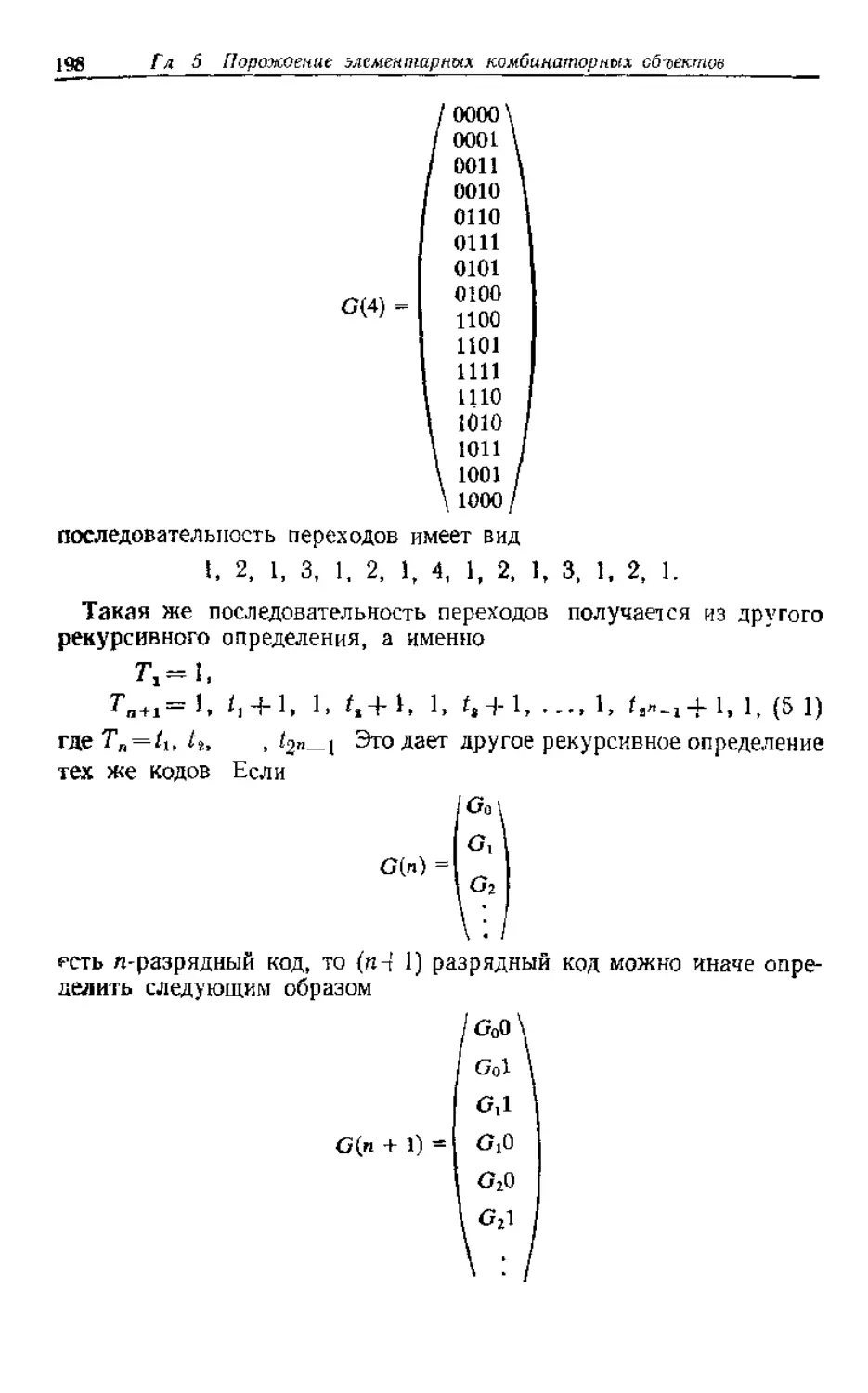

COMBINATORIAL

ALGORITHMS

THEORY

AND PRACTICE

EDWARD M REINGOLD

Department of Computer Science

University of Illinois at Urbana-Cbampaign

JURC NIEVERGELT

Department of Computer Science

University of Illinois at Urbana Champaign

Swiss Federal Institute of technology, Zurich

NARSINGH DEO

Department of Electrical Engineering and Computer

Science Programme

Indian Institute of Technology, Kanpur

Prentice-Hall, Inc , Englewood Cliffs,

New Jersey 07632

1977

Э. РЕЙНГОЛЬД, Ю. НИВЕРГЕЛЬТ, Н.ДЕО

КОМБИНАТОРНЫЕ

АЛГОРИТМЫ

ТЕОРИЯ

И ПРАКТИКА

Перевод с английского

Е П ЛИПАТОВА

под редакцией

В. Ь. АЛЕКСЕЕВА

ИЗДАТЕЛЬСТВО «МИР» МОСКВА 1980

УДК 681 142 2

(М.: Мир. 1у77). паписаннои совместно с Дж Фарраром, В данной

Редакция литературы по математический наукам

1702070000 , г. х г. ,

© 1977 by Prentice-Hall, Inc.,

20204-028 Englewood Cliffs, New Jersey 07632

041(01)-8O ' © Перевод на русский язык, «Мир», 1980

ОТ РЕДАКТОРА ПЕРЕВОДА

Задачи алгоритмического характера на дискретных конечных

структурах встречаются в практике постоянно. Однако долгое

время они не привлекали к себе внимания исследователей, так как

в большинстве случаев для их решения находился какой-либо

естественный алгоритм (обычно тина перебора) Поиск более хо-

роших алгоритмов не мог представлять интереса ни для задач

малой размерности, ни для задач большой размерности, поскольку

в первом случае такие алгоритмы ненамного лучше естественного,

а во втором — они так же, как и естественный алгоритм, не при-

водят к решению из-за большого объема вычислений

Повсеместное применение ЭВМ существенно изменило положе-

ние, так как стало возможным решать задачи большей размерности

Оказалось, что для таких задач различные усовершенствования

естественных алгоритмов могут давать существенный выигрыш во

времени работы или требуемой памяти Необходимость практи-

ческого решения широкого круга комбинаторных задач привела

к появлению большого количества усовершенствований естествен-

ных алгоритмов, а во многих случаях и к построению принципи-

ально новых алгоритмов, Это в свою очередь потребовало разра-

ботки теоретических методов сравнения их качества, а также

исследования общих принципов построения хороших комбинатор-

ных алгоритмов.

Этим вопросам и посвящена данная книга В ней методы оценки

эффективности и общие принципы построения алгоритмов иллю-

стрируются на различных комбинаторных задачах, среди которых

наибольшее внимание уделяется очень важным для работы с боль-

шими массивами данных алгоритмам поиска и сортировки, а также

получившим широкое развитие алгоритмам на графах

В последние годы появилось три довольно исчерпывающих

издания на русском языке, систематически освещающих вопросы,

связанные с комбинаторными алгоритмами. Khvt Д Искусство

программирования для ЭВМ, т 1 — 3 — М.: Мир, 1976—1978, Кри-

стофидес Н Теория графов Алгоритмический подход- At. Мир,

1978, Ахо А , Хопкрофт Дж , Ульман Дж Построение и анализ

вычислительных алгоритмов — М • Мир, 1979

Предлагаемую вниманию читателей книгу М Рейнгольда,

Дж Нивергельта и Н. Део отличает удачное сочетание компакт-

ности изложения с весьма подробной разработкой темы, что позво-

ляет легко и быстро ознакомиться с предметом

Определенные трудности при переводе вызвала терминология,

так как в рассматриваемой области она еще не устоялась В боль-

шинстве случаев здесь использована терминология, принятая в

переводах упомянутых выше монографий Д Кнута и А. Ахо, Дж

Хопкрофта и Дж. Ульмана.

В Б Алексеев

ПРЕДИСЛОВИЕ

Комбинаторные алгоритмы предназначаются для выполнения

вычислений на дискретных конечных математических структурах

Это новое направление, и лишь несколько лет тому назад оно стало

превращаться из набора не связанных между собой вычислитель-

ных приемов в систематическую область знаний Становлению

этой новой дисциплины способствовали следующие три фактора

Возрастающая роль вычислении комбинаторного характера в

прикладных задачах по сравнению с другими вычислениями

Явный прогресс разработки и анализа алгоритмов, касающийся

прежде всего математической стороны дела

Переход от изучения частных комбинаторных алгоритмов к

исследованию свойств, присущих классу алгоритмов

Совокупность этих факторов и выделила комбинаторные алго-

ритмы как новую важную дисциплину на грани программирования

и математики Курсы комбинаторных алгоритмов и примыкающие

к ним курсы анализа алгоритмов теперь изучаются в колледжах

и университетах на отделениях программирования, математики,

электротехники и исследования операций

Способы представления комбинаторных алюритмов довольно

разнообразны, и лекции или учебники по этому предмету могут

предназначаться для разных аудиторий Настоящая книга обра-

щена к читателю, которого можно охарактеризовать как обладаю-

щего больше программистской, нежели математической квалифи-

кацией, к читателю, который интересуется комбинаторными алго-

ритмами в силу их практического значения. Таким образом, при

написании книги мы руководствовались в основном следующими

целями.

Выбрать те темы, которые имеют отношение к практическим

вычислениям (и все же отдельные вопросы, представляющие не

столько практическим, сколько математический интерес, были в

книгу включены).

Выделить аспекты алгоритмов, важные с точки зрения их реа-

лизации, и опустить детали, которые может восполнить любой ком-

петентный программист.

Представить математические рассуждения, там где они необ-

ходимы, в интуитивно понятной форме

Уровень подготовки читателя. Подготовка, требующаяся для

понимания материала книги, несколько меняется от главы к главе

Минимум необходимых познаний в программировании соответст-

вует уровню первокурсника-программиста, уже научившегося

писать довольно пространные программы Этой подготовки было бы

достаточно для понимания обсуждаемых атгоритмов, которые

представлены в обозначениях, аналогичных современным языкам

программирования высокого уровня Кроме того весьма желательно

знакомство со структурами данных и обработкой списков в объеме

второго курса факультета программирования Необходимый уро-

вень математического образования соответствует типичной подго

товке студента, прослушавшего ряд математических курсов помимо

математического анализа

Разделы со звездочкой. Два раздела этой книги помечены зна-

ком * Раздел 3.4 помечен потому, что для его чтения требуется

знакомство с нетривиальными математическими понятиями, а

раздел 8 6 — потому, что он сложен по существу Эти разделы

можно рассматривать как необязательные Звездочкой помечены

и соответствующие им упражнения, а также другие упражнения,

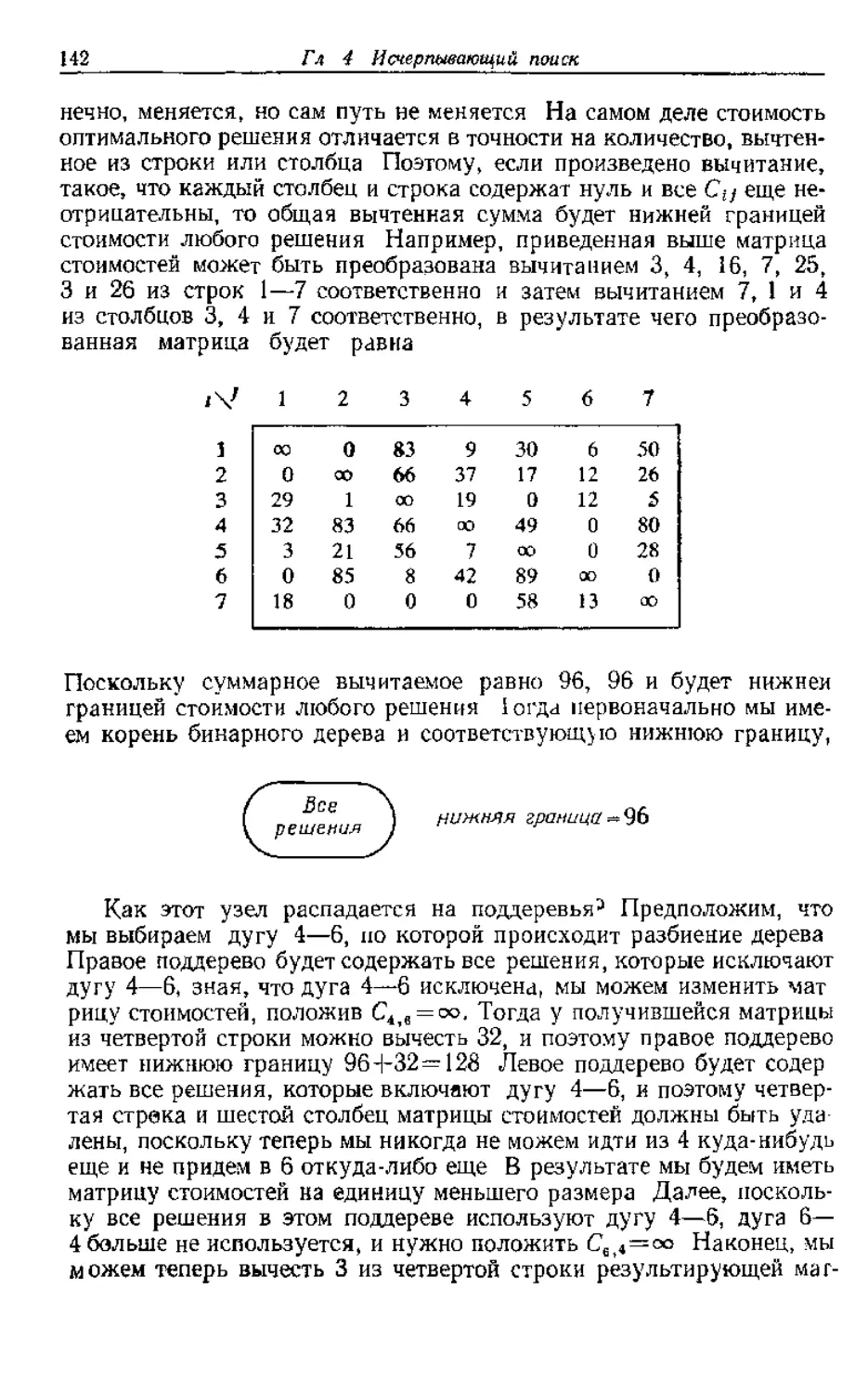

требующие серьезной математической подготовки или имеющие

необычно сложное решение.

Общая организация. Зависимость между девятью главами обо-

значена на следующей диаграмме, в которой «сильная» зависимость

показана сплошными стрелками, а «слабая»—пх актирными

В гл 1 дается обзор содержания всей книги В ней также пред-

ставлены отдельные темы и методы, которые вновь появляются в

последующих главах

В гл. 2 и 3 обсуждаются соответственно структуры данных и

методы перечисления Весь материал, содержащийся в этих двух

главах, кроме разд 3 4, служит основой для остальной части книги

Однако, возможно, удобнее было бы раскрывать темы этих глав,

когда они необходимы для изложения материала последующих

глав Здесь использован иной подход с целью попытаться сделать

гл 4—9 по возможности не зависящими друг от друга

Материал гл 4 об исчерпывающем поиске важен для понимания

гл 5, в которой фактически методы гл 4 пересматриваются для

случая простых комбинаторных объектов По некоторым причинам

материал гл 4 является решающим для понимания многих раз-

делов гл 8 об алгоритмах на графах Глава 9 служит продолже-

нием гл. 4 и 8, в ней исследуются некоторые теоретические вопросы,

возникающие в связи с неудачами программистов и математиков в

поиске «эффективных» алгоритмов для решения некоторых из

обсуждаемых задач. В гл. 6 и 7 описываются наиболее распро-

страненные комбинаторные алгоритмы: поиск и сортировка. Эти

главы больше других опираются на материал гл 2 и 3.

Благодарности

В словаре Г У. Фаулера (Н W Fowler, A Dictionary of Modern

English Usage, sec ed , revised and edited by Sir Ernest Gowers,

Oxford University Press, New York and Oxford, 1965) статья «Не-

логичность» начинается так

Нам посчастливилось иметь много таких критически настроенных

читателей, изучивших всю или часть рукописи этой книги, и они

помогли найти различные примеры «нелогичностей» Мы очень

признательны Джеймсу Р Битнеру, Эллану Б Бородину, Джеймсу

Э Филлу, У Д Фрейзеру, Брайену Э Хенше, Уилфреду Дж Хан-

сену, Эллису Горовицу, Алону Йтаи, Дональду Б Джонсону,

Джону Э. Коху, Дер-цзай Ли, Карлу Либергерру, К Л Лю,

Прабхакеру Матети, Иешуа Перлу, Дэвиду Э Плайстеду, Эндрю

Г. Шерману, Роберту Э Тарьяну, Дэниелю С Ватанабе, Ли Дж.

Уайту, Томасу Р Уилкоксу и Герберту С Уилфу Без их неоце-

нимой помоши книга была бы хуже

Мы в особом долгу перед Джеймсом Э филлом за его тщатель-

ную подготовку ответов к упражнениям.

Мы обязаны Университету штата Иллинойс в Урбана — Шам-

пейн, Швейцарской высшей технической школе, Научной лабора-

тории Лос-Аламоса, Вейцмановскому институту науки, Универ-

ситету штата Вашингтон и Индийскому технологическому инсти-

туту в Канпуре за обеспечение благоприятных условий для подго-

товки этой кни1и Их поддержка сильно облегчила нашу задачу.

Наконец, мы хотели бы выразить признательность и благодар-

ность Конни Носбич и Джун Уинглер, нашим секретарям в Уни-

верситете штата Иллинойс, за терпеливую, добросовестную и ква-

лифицированную перепечатку (в том числе иногда неоднократную)

рукописи

Эдвард М Рейнгольд

Юрг Нивергелып

Парсинг Део

Глава 1. Что такое комбинаторные

вычисления?

Предметом теории комбинаторных алгоритмов, часто называ-

емой комбинаторными вычислениями, являются вычисления на

дискретных математических структурах Это новое направление

исследований Лишь в последние несколько лет из наборов искус-

ных приемов и разрозненных алгоритмов сформировалась система

знаний о разработке, реализации и анализе атгоритмов

Может быть полезно провести аналогию с более устоявшейся

дисциплиной- комбинаторные вычисления находятся в таком же

отношении к комбинаторной математике (дискретной, конечной

математике), как численные методы анализа к анализу. Мы явля-

емся свидетелями того, что комбинаторные вычисления развиваются

сегодня так же, как и численные методы анализа в 50 е годы, а

именно

интенсивно изобретаются новые алгоритмы;

происходит быстрый прогресс, главным образом в математи-

ческом плане, в понимании алгоритмов, их разработки и

анализа,

происходит переход от изучения отдельных алгоритмов к

исследованию свойств, присущих классам алгоритмов

Активизации комбинаторных вычислении в последнее время,

несомненно, способствовало растущее практическое значение вы-

числений комбинаторного характера Есть все основания считать,

что в прикладных программах объем вычислений комбинаторного

характера будет расти быстрее, чем объем численных расчетов,

поскольку, за исключением традиционных областей приложения

математики к физическим дисциплинам, дискретные математические

структуры встречаются чаще, чем непрерывные, и доля машинного

времени, затрачиваемою на физические задачи, убывает Следова-

тельно, пользователи и прикладные программисты вероятно, будут

вынуждены решать задачи больше комбинаторного, чем численного

характера

В отличие от некоторых других разделов математики комбина-

торные вычисления не имеют «ядра», т е некоторого количества

«фундаментальных теорем», составляющих суть предмета, из ко-

торых выводится большинство результатов Сначала может пока-

12

заться, что в целом эта область состоит из наборов специальных

методов и хитрых приемов Действительно, остроумные приемы

играют здесь известную роль и, для того чтобы проиллюстрировать

это, в данной главе мы рассмотрим некоторые примеры техники

«игры на двоичности» Однако, после того как было исследовано

много комбинаторных алгоритмов, стали вырисовываться неко-

торые общие принципы Именно эти принципы делают комбина

торные вычисления связной областью знании и позволяют изло

жить ее и систематизированном виде

Цель данной главы состоит в том, чтобы проиллюстрировать

на примерах некоторые из этих главных принципов' кроме того,

она является введением в некоторые темы и методы, которые в

последующих главах будут изучены более глубоко

Глава построена так, что изложение переходит от конкретных

задач к более абстрактным принципам, причем применение не-

которых из этих принципов к анализу алгоритмов требуез раз

витой математической теории Поэтому абстрактные разделы главы

являются более сложными, чем остальные; в этом смысле первая

глава точно отображает ту область науки, введением в которую

она является В разд. 1 1 и 1 2 приводятся примеры творческого

подхода и изобретательности при синтезе эффективно работающих

алгоритмов В разд 1 3 и 1 4 изложены общие принципы синтеза

алгоритмов И наконец, в разд. 1 5 и 1 6 приведены методы анализа

алгоритмов Разработка, анализ и реализация алгоритмов состав-

ляют сущность комбинаторных вычислений

1.1. ПРИМЕР. ПОДСЧЕТ ЧИСЛА ЕДИНИЦ В ДВОИЧНОМ

НАБОРЕ

Двоичные наборы, т е последовательности на нулей и единиц,

являются носителями информации фактически во всех современных

вычислительных устройствах Однако большинство программистов

редко работают с информацией на уровне двоичных наборов Это,

траммист обычно имеет дело с арифметическими операциями и

редко касается вопросов внутреннего представления чисел С дру-

гой стороны, в областях, не так хорошо устоявшихся, как числен-

ные расчеты, некоторые важные операции над данными нельзя

ввести в вычислительное устройство или языки программирования

высокого уровня, Так, в некоторых часто встречающихся в комби-

наторных вычислениях классах операции для эффективного про-

граммирования необходимо знание алгоритмов, которые работают

на уровне двоичных символов Со временем, когда эти операции

будут более широко известны, они, вероятно, будут вводиться в

вычислительные устройства и языки программирования Пока же

такие операции являются необходимым инструментом для каждого,

кто программирует комбинаторные алгоритмы

В качестве примера рассмотрим задачу подсчета числа единиц

в двоичной последовательности B~bnbn 3 babi длины п Такая

операция является естественной, если представить себе, чго набор

В задает подмножество S некоторою множества U с п этементами

так, что единицы указывают на те элементы множества U, которые

принадлежат S Тогда указанная операция определяет число эле-

ментов в S

Сразу на ум приходит следующий алгоритм решения такой

задачи- последовательно просматривать каждый раздел и, если

он равен единице, в счетчике задават ь соответствующее приращение.

Дпя некоторых вычислительных устройств алгоритм 1 1 может

оказаться наиболее разумным, однако, большинство вычислитель-

ных устройств имеет специфические особенности, которые позво-

ляют для этих целей использовать более быстрые алгоритмы. Пред-

положим, что память состоит из ячеек, которые могут хранить дво-

ичные слова длины п и что вычислительное устройство может вы-

полнять логические или булевы операции параллельно над каждым

разрядом слова Предположим, кроме того, что вычислительное

устройство может производить арифметические операции, которые

интерпретируют эти слова как беззнаковые целые неотрицательные

числа, записанные в двоичной системе счисления.

Рассмотрим алгоритм 12. Высказывание «В^-В/\(В—I)» со-

держит интересную операцию, использующую сделанные выше

предположения Д — логическая операция «и», которая опери

рует параллельно с каждыми дв>мя соответствующими разрядами

пары аргументов В и В—1 «—» — арифметическая операция вы-

читания над двоичными целыми числами На примере очень хорошо

видно что операция В/\ (В—1) заменяет у В самую правую единицу

нулем.

В Н 1001000

В - 1 111000111

В л (В - 1) I 11000000

Цикл в алгоритме 1 2 повторяется до тех пор, пока В не станет

равным нулю, т е не будет состоять из одних нулей В то время,

как цикл в алгоритме 1 1 всегда повторяется п раз, в алгоритме 1 2

цикл повторяется лишь столько раз, сколько единиц в наборе В

Иначе говоря, алгоритм I 2 работает только с единицами в В, не

зная a priori их расположения Этот алгоритм, очевидно, эффек-

тивен, когда он применяется к «разреженным» словам, т. е. наборам

с малым числом единиц Он является «хитрым» в том смысле, что

сложным образом зависит от способа представления чисел (осо-

бенно отрицательных) в вычислительном устройстве, что с точки

зрения первоначальной постановки задачи является совершенно

посторонним

Более интересен алгоритм, изложенный далее. С алгоритмом 1 1

он имеет одно общее важное свойство повторение цикла фикси-

рованное число раз, зависящее от п и не зависящее от В. В ю же

время в отличие от алгоритма I 1, повторяющего свой цикл п раз,

в алгоритме 1 3 (подробного изложения которого мы не даем) цикл

повторяется только Ign") раз1) Для типичного слова длины 32

(или 64) цикл повторяется пять (соответственно шесть) раз, т. е.

алгоритм 1.3 является значительно более быстрым, чем алгоритм

1 1 Алгоритм 1 3 исходит из тех же предположений о возможностях

вычислительного устройства, что и алгоритм 1 2 Дополнительно

требуется, чтобы существовал способ быстро сдвигать слово на 1, 2,

4, 8 разрядов

Этот алгоритм лучше всего объяснить на конкретном примере

в

Ья Ь7 Ь6 Ь5 Ь4 6, Ьг bi

1 1 0 1 0 0 0 1

1 Сначала выделяются разряды с нечетными номерами Ь., &6,

bi и слева от каждого из них приписываются пули Полученный

таким образом набор обозначим Внеч

Затем выделяются четные координаты и сдвигаются вправо на

один разряд на места разрядов Ь7, Ьь, Ьз, bt соответственно К каж

дому из разрядов припишем слева нуль, а полученную таким об-

разом строку обозначим Вчег

(Нули, приписанные разрядам, выделены мелким шрифтом, чтобы

отличить их от нулей, входящих в набор В ) После этого склады-

ваем два числа, двоичными представлениями которых являются

И Вчст Через В' обозначим набор, представляющий собой

двоичную запись результата суммирования

b's ft? Ь'ь b's Ь, Ь'з b'2 Ъ*1

Впеч

В'

0 10 1 0 0 0 1

0 1 0 0 0 0 0 0

1 0 0 1 0 0 0 1

к.

о 0 1 о о 0 1

Виет I О

о 1 0 и о О О

Складываем два числа Вкеч и Вчет Двоичную запись этой

суммы обозначим В”

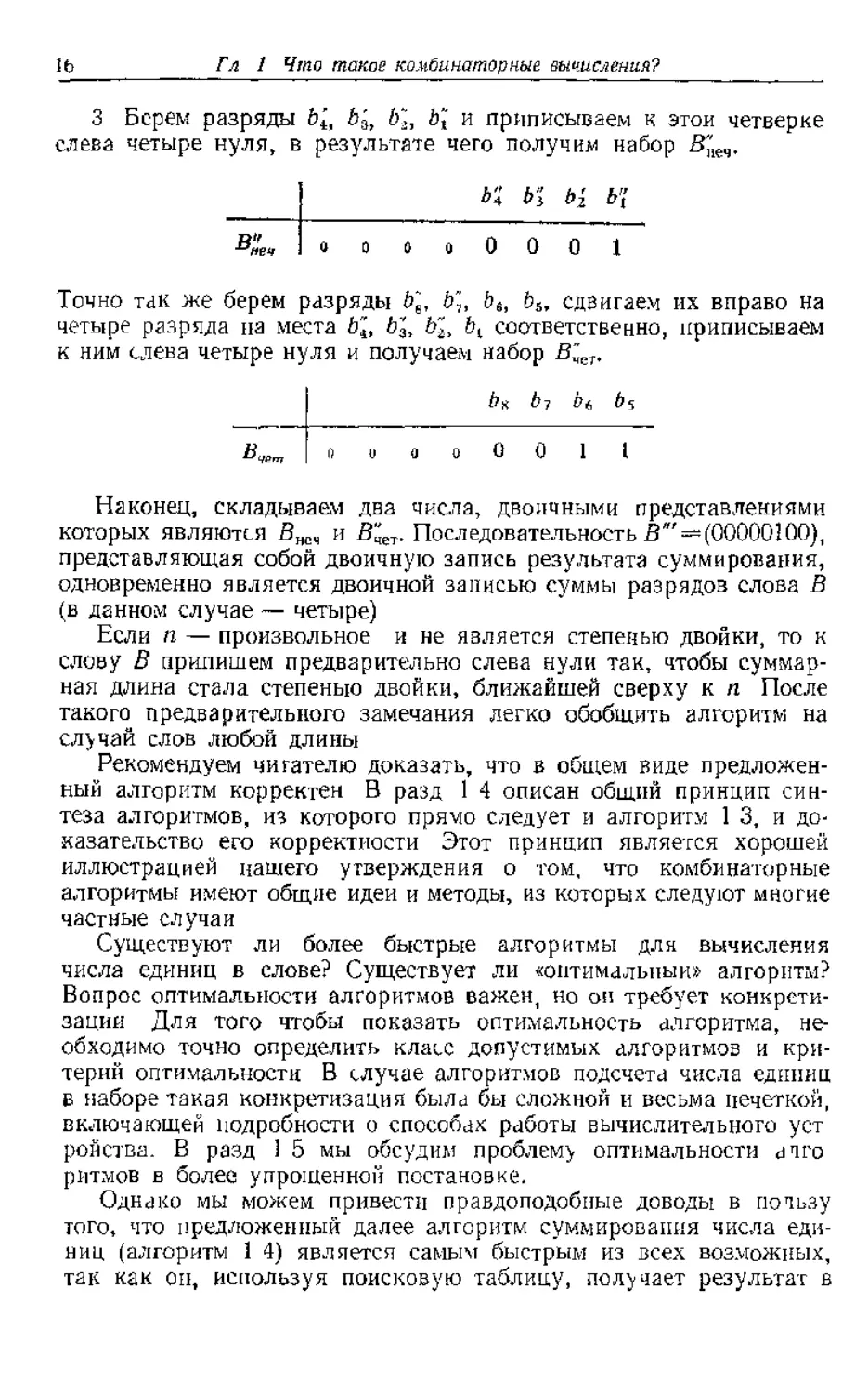

3 Берем разряды b'it b3, b~,, й'( и приписываем к этой четверке

слева четыре нуля, в результате чего получим набор б''1еч.

о о 0 0 0 1

Точно так же берем разряды Ь~е, Ь\, bt, й5, сдвигаем их вправо на

четыре разряда па места b"t, b"3, b“t, bi соответственно, приписываем

к ним слева четыре нуля и получаем набор В^,„.

I Ьх by Ь/, b$

Вчет | о и о о О 0 1 1

Наконец, складываем два числа, двоичными представлениями

которых являются Внсч и В"чет. Последовательность В"' = (00000100),

представляющая собой двоичную запись результата суммирования,

одновременно является двоичной записью суммы разрядов слова В

(в данном случае — четыре)

Если п — произвольное и не является степенью двойки, то к

слову В припишем предварительно слева нули так, чтобы суммар-

ная длина стала степенью двойки, ближайшей сверху к п После

такого предварительного замечания легко обобщить алгоритм на

случай слов любой длины

Рекомендуем читателю доказать, что в общем виде предложен-

ный алгоритм корректен В разд 1 4 описан общий принцип син-

теза алгоритмов, из которого прямо следует и алгоритм 1 3, и до-

казательство его корректности Этот принцип является хорошей

иллюстрацией нашего утверждения о том, что комбинаторные

алгоритмы имеют общие идеи и методы, из которых следуют многие

частные случаи

Существуют ли более быстрые алгоритмы для вычисления

числа единиц в слове? Существует ли «оптимальный» алгоритм?

Вопрос оптимальности алгоритмов важен, но он требует конкрети-

зации Для того чтобы показать оптимальность алгоритма, не-

обходимо точно определить класс допустимых алгоритмов и кри-

терий оптимальности В случае алгоритмов подсчета числа единиц

в наборе такая конкретизация была бы сложной и весьма нечеткой,

включающей подробности о способах работы вычислительного уст

ройства. В разд 1 5 мы обсудим проблему оптимальности ачго

ритмов в более упрощенной постановке.

Однако мы можем привести правдоподобные доводы в пользу

того, что предложенный далее алгоритм суммирования числа еди-

ниц (алгоритм 1 4) является самым быстрым из всех возможных,

так как он, используя поисковую таблицу, получает результат в

следующего вида

Какой самый быстрый путь поиска В в этой таблице’5 При тех

же предположениях, что и в предыдущих алгоритмах, можно счи-

тать В адресом ячейки памяти, содержащей сумму единиц в В

Этот факт и дает нам алгоритм, требующий только одного обращения

к памяти

Завершая раздел, отметим большое разнообразие существующих

алгоритмов вычисления числа единиц в наборе, которые основаны

на совершенно разных принципах Алгоритмы 1 1 и 1 4 решают

задачу «в лоб» алгоритм 1 1 просматривает каждый разряд и

поэтому требует много времени, алгоритм 1 4 хранит решение для

каждого набора и поэтому требует большого объема памяти Ал-

горитм 1 3 является изящным компромиссом между ними.

1,2. ПРОБЛЕМА ПРЕДСТАВЛЕНИЯ:

КОДЫ, СОХРАНЯЮЩИЕ РАЗНОСТИ

Следующей чрезвычайно важной проблемой в комбинаторных

вычислениях является задача эффективного представления объек-

тов, подлежащих обработке Эти объекты могут быть такими же

простыми, как двоичные наборы в предыдущем примере, или та-

кими сложными, как сети дорог или органические молекулы Про-

блема возникает по той причине, что обычно имеется много воз-

можных способов представления сложных объектов более простыми

структурами, которые можно заложить в вычислительное устрой

ство или языки программирования, но не все такие представления

в одинаковой степени эффективны с точки зрения времени и памяти

Более того, идеальное представление зависит от вида производи-

мых операций

В данном разделе эта ситуация проиллюстрирована приме-

рами, в которых мы хотим определить весьма специфические опе-

рации над целыми Целые определяются как данные простейшего

типа почти во всех вычислительных устройствах и языках програм-

мирования, и, таким образом, проблема представления, как

правило, не возникает; имеющееся представление (выбираемое кон-

структором вычислительной машины) почти всегда наилучшее.

Однако существуют некоторые заслуживающие внимания исклю-

чения, когда выгодно (или даже необходимо) использовать пред-

ставление целых в вычислительном устройстве иным способом

&ги исключения появляются в следующих случаях-

1) необходимы целые, большие имеющихся непосредственно

в аппаратном оборудовании,

2) необходимы только небольшие целые, и требуется сэкономить

память, упаковывая их по несколько в одну ячейку,

3) действия с целыми производятся не общепринятыми ариф-

метическими операциями,

4) целые используются для представления других типов объек-

тов, и необходимо иметь возможность легко обращать целое в со-

ответствующий ему объект и образно (этот важный случай преды-

дущего исключения появится в 1л 5).

Обсуждаемая в этом разделе проблема кодов, сохраняющих

разности, касается случаев 2 и 3

В задачах распознавания образов и классификации для решения

вопроса, будут ли два объекта X и У эквивалентными, стандартной

является следующая процедура X и Y представляются векторами

признаков (лг, х2, ..xt) и (yt, у2, , У/) соответственно, где каж-

дая компонента означает признак объекта, выраженный целым

значением Считается, что X и У эквивалентны тогда и только

тогда, когда

где t — целое, называемое порогом.

В типичных приложениях (таких, как денситометрия в задачах

представлания непрерывных сигналов цифровыми, подсчет числа

букв в английских словах или подсчет числа вершин в графе, ко-

торый является абстрактным представлением написанной от руки

буквы) можно считать, что и компоненты, и порог принимают лишь

небольшие целые значения В этих случаях несколько компонент

EEEEEEEEEEEHEEEE1ZZD

Ячейка. 1

запо, что выделенные зоны могут даже состоять из частей двух

соседних ячеек памяти

На первый взгляд кажется, что для вычисления Six;—yd не-

обходимо последовательно выделять пары соответствующих компо-

нент векторов признаков и затем сдвигать каждую из них на соот-

ветствующее место для вычитания В этом разделе будет показано,

что если целые представить в специальном виде (в виде кодов, со-

храняющих разности), операцию сравнения суммы разностей с

порогом можно значительно ускорить, если выполнять все операции

над потной ячейкой памяти, игнорируя при этом границу между

зонами Ускорение особенно эффективно в вычислительных уст-

ройствах с длинными словами и аппаратно реализованной опера-

цией нахождения числа единиц в стове

Код 3>, сохраняющий разности (DP-код), есть отображение

множества {!, 2, . , jV} в множество {0, 1 }п двоичных

последовательностей длины п со следующими свойствами Для всех

целых I, j, таких, что

1) из |т—следует H(Dlt Dj}-=\t

2) из U—/Г>£ следует H(Dt,

где H(D„ Dj) — расстояние Хемминеа между двумя кодовыми

словами D, и DJt т е число разрядов, в которых они различаются,

a t — порог Интуитивно ясно, что код Я) сохраняет малые раз-

ности, а большие разности смешивает все вместе 3) называют

п-разрядным DP-t-кодом ранга N, или иногда (п, fj-кодом ранга N

Легки проверить, что ес ш компоненты двух векторов призна-

выполпепо, если и только если хсммингово расстояние между пред-

ставлениями X и Y не больше I Это свойство позволяет эффективно

сравнивать векторы признаков, что указывалось выше.

В приведенном ниже примере код имеет ранг N—8, длину п=4

равным единице

щими целыми числами) Заметим, что смежными являются только

те кодовые слова, номера которых отличаются на единицу

В табл 1 1 приведены максимальные ранги, которые можно

получить для п^б Соответствующие оптимальные коды довольно

легко можно построить вручную для nsCo и с помощью ЭВМ для

п=6 Мы не знаем рангов оптимальных кодов для п—7, так как

J

программа построения их для п-~6 не позволяет в реальное время

решить эту же задачу для н=7 Случай п—6 подробно рассмотрен

в разд 4 1 5 Это рассуждение иллюстрирует эмпирическое пра-

вило, которое удивительно часто присутствует в комбинаторных

алгоритмах Учитывая, что многие интересные комбинаторные

задачи содержат параметр, который естественным образом опреде-

параметром является длина слова и), эмпирическое правило гласит.

1.3. СПОСОБЫ композиции

Дпа предыдущих примера проникнуты духом «игры на двоично-

сти»— остроумной и изобретательной, но весьма специфической

техники, которая хорошо работает па одно» задаче, но нс обобща-

ется и не переносится на другую. С целью предупредить читателя

от заключения, что комбинаторные вычисления представляют собой

лишь набор разрозненных искусных приемов, в этом и следующем

разделах мы обсудим два общих принципа; мы покажем также, как

их можно использовать в таких специальных задачах, как построе-

ние алгоритма для подсчета числа единиц в двоичном наборе и кон-

струирование кодов, сохраняющих разности Излагаемые ниже

принципы композиции решений и декомпозиции задачи обладают

такой общностью, что возможность их применения не ограничи-

вается только комбинаторными вычислениями, оба они полезны при

решении любой математической задачи.

Принцип композиции, который является предметом этого раз

дела, приводит нас к построению сложных объектов путем соеди

нения более простых. Чы проиллюстрируем этот принцип на при

мере конструирования больших DP-кодов Заметим, что для малых

значений рани ,V и порога t (особенно если /=1) DP-коды легко

строятся вручнупо. Чтобы построить коды большого ранга и/или

двух способов композиции, один из которых увеличивает ранг без

изменения порога, а другой, увеличивая порог, лишь незначительно

увеличивает ранг. Оба способа композиции базируются на идее

образования составного кодового слова из слов двух различных

кодов путем приписывания их друг к дрхп

Сложение порогов. Пусть Dlt D 2, , есть (п, .

, , Ем есть (т, и) код Тогда последовательность

Ци + .^за ъ >,

7И И + 1 р в противном случае

Если Nite&M/u, то ран! составного кода приблизительно равен

N+M Например, при композиции оптимальных (3, 1)- и (4, 2)-

кодов, получается (7, 3)-код ража 9

Fx = OOOO

E-, - 0001

E, = OOH

/-4=0111

Es = Illi

£6 = 1110

D,Et = 0000000

P2t( = 0010000

£)гЕг = 0010001

DjE, = 00100H

D,E, = 011001 1

/>,е4 - 011(11 I I

DJ-< - Ollllll

D,F< Hill 10

есть (n+m, f)-Koj ранга

Например, при композиции оптимального (3, 2) кода ранга 4 с

самим собой, мы получим (6, 2)-код ранга 50

рвчг R - IО

D, = Еу = ООО

[)2 - Е2= 001

Dy = £, = 011

D„ = £4 = 111

= 000000

= 000001

= 000011

= 00011J

= Oil 111

= 111111

= HIGH

’ 111001

- 111000

1.4 СПОСОБЫ ДЕКОМПОЗИЦИИ

Принцип декомпозиции приводит нас к решению задачи о сложном

объекте путем разложения его на какое то число меньших, решению

той же самой задачи для каждого из меньших объектов и затем

композиции найденных решений. Дчя того чтобы обеспечить окон-

чание процедуры, достаточно для простых объектов прекратить

процесс декомпозиции и решать задачу непосредственно для них

Именно этот принцип приводит к эффективному и изящному алго-

ритму суммирования единиц в двоичной последовательности длины

п (алгоритм 1 3 из разд 1 1)

Пусть B=bn . b2bi — двоичный набор длины п., и пусть S (В) —

сумма единиц в нем Зададимся некоторым h и разделим В на две

части Вl—bn ..bh+1 и ВГ=ЬЬ . b-J^ S(B), очевидно, удовлетворяет

следующему рекуррентному соотношению

3(В) = 5(В;)+Ж)

Это означает, что 3 (В) можно получить за одну операцию сложе-

такие же рассуждения для Bt и Вг, затем для поднаборов, которые

они порождают, и т д, мы получим процесс вычисления S(B)

при условии, что мы можем подсчитать число единиц в достаточно

коротких наборах Если фразу «достаточно короткий» понимать

как «длины один» и считать S(B)=B для n—1, то станет ясно, как

можно вычислить число единиц в наборе последовательным сумми

рованием Очевидно, этот процесс зависит от способа разбиения

набора В и его поднаборов

Рассмотрим две экстремальные стратегии разбиения В первой

выберем h=n—1, тогда Bi=bn и Br—bn t Ь2Ьг В этом случае

последовательно слева направо просматриваются все разряды

При такой стратегии требуется п— 1 сложений (алгоритм 1 1)

Во втором случае положим Тогда В(=&Г1 |<i и

Ву=^_л-[. .ЬгЬи Этот способ решения задачи, при котором оди-

наково обрабатываются обе части набора В (Bt и Вг) и В всегда

разбивается примерно пополам, приводит к алгоритму 1.3, по для

того, чтобы это стало очевидным, требуется остроумная идея

Заметим, что в этом алгоритме все еще надо осуществить п—1 ело

вать п—1 сложений (упражнение 5) Следовательно, дтя того чтобы

получить логарифмическую скорость работы алгоритма 1.3, мы

должны сделать так, чтобы несколько операций сложения в корот-

ких наборах производились путем применения единственной one

рации в длинных. Как это сделать, показано па рис 1.3 S(B)

теперь означает не только сумму единиц в наборе, но также (что

более существенно) — набор, который является двоичной записью

числа единиц в слове В, дополненный слева пулями до соответст-

15 Классы аггоритчов

ООО ... ООО । rl ।

+ ООО ... ООО । ।

= 5(ЯГ)|

1.5. КЛАССЫ АЛГОРИТМОВ

при таком определении становится возможным говорить, что дан-

ный алгоритм является оптимальным по отношению к некоторому

свойству, если он работает по крайней мере так же хорошо (отно-

сительно этого свойства), как любой другой алгоритм из рассмат-

риваемого класса Знание того, что имеющийся алгоритм является

оптимальным, может предотвратить поиск не существующего 4V4-

шего алгоритма

Как можно строго определить (возможно, бесконечный) класс

алгоритмов? Исследуем этот вопрос на примере задачи о фальшивой

монете Рассматриваемый в этом примере класс алгоритмов порож-

дает более обширный и более важный класс алгоритмов — так

называемые деревья решений

Одна из формулировок задачи о фальшивой монете такова

Имеется п монет, о которых известно, что п—1 из них являются

настоящими и не более, чем одна монета фальшивая (легче или

тяжелее остальных монет). Дополнительно к группе из п сомни-

тельных монет дается еще одна монета, причем заведомо известно,

что она настоящая. Имеются также весы, с помощью которых мы

можем сравнивать общий вес любых т монет в общим весом любых

других т монет и гем самым установить, имеют ли две группы

по т монет одинаковый вес, либо одна из групп легче другой За-

дача состоит в том, чтобы найти фальшивую монету (если она есть)

за наименьшее число взвешиваний, или сравнений Число срав-

нений, необходимых в алгоритме, можно определять различными

способами; наиболее разумными являются рассмотрение среднего

числа сравнений и числа сравнений в худшем случае Этот вопрос

мы обсудим в дальнейшем после определения рассматриваемого

класса алгоритмов

Пусть сомнительные монеты занумерованы числами 1, 2, , п;

монете, о которой известно, что она настоящая, поставим в со-

ответствие номер 0. Пусть теперь S={0, 1, 2, п}— множество

монет Если Si, S2— иепересекающиеся непустые подмножества

множества S, то через Ss, . S2 обозначим операцию сравнения весов

множеств St и S2 При сравнении возможны три исхода, которые

мы будем обозначать следующим образом Si<S-3, Si=S2 или Si>S2

в зависимости от того, является ли вес St меньшим, равным или

большим веса S2

Рассматриваемые алгоритмы можно представить в форме (тер-

нарного) дерева решений. Дерево на рис. 1 4 для случая четырех

монет иллюстрирует введенные нами понятия и обозначения В тех

случаях, когда это не вызывает путаницы, мы при обозначении

множеств будем опускать скобки Корень дерева на рис 1 4 изоб-

ражен в виде кружка и помечен отношением 1 : 2, это означает,

что алгоритм начинает работу сравнением весов монет с номерами

I и 2 Три исходящие из корня ветви ведут к поддеревьям, опреде-

ляющим продолжение работы алгоритма после каждого из трех

возможных исходов первого сравнения Квадраты, называемые

листьями дерева, означают, что работа алгоритма заканчивается.

работы требует алгоритм в среднем, однако для этого требуется

задать вероятности различных исходов Если мы предположим,

что все девять исходов 1L, IН, 2L, 2Н, 3L, ЗН, 4L, 4Н, G равнове-

роятны, то тогда этот алгоритм требует в среднем 7/3 сравнений

На одну чашку весов мы можем положить больше одной монеты.

Например, можно начать сравнения, положив на одну чашку весов

монеты 1 и 2, а на другую — монеты 3 и 4 (рис 1.5) Если посчаст-

ливится, задачу можно решить за одно сравнение — это может

произойти, когда все монеты настоящие. Однако ясно, что неза-

висимо от того, как дополняется это дерево решений, в худшем

случае задача все равно потребует тех же трех сравнений, поскольку

единственное тернарное решение, вообще говоря, не может иден-

тифицировать один из четырех исходов, которые возможны на вет-

ви, помеченной символом «С», так же как и один из четырех ис-

ходов на ветви, помеченной символом «>» К tomv же независимо

от того, как дополняеюя это дерево решений, оно потребует в сред-

нем по крайней мере 7/3 сравнений (почему’), и в этом смысле оно

не лучше, чем дерево на рис. 1.4.

1 Каждый узел помечен сравнением Sx • S2, где Sx и S2 — не-

пересекающиеся непустые подмножества множества S={0, 1, 2,

,, п} всех монет.

2 Каждый лист либо не помечен (что соответствует невозмож-

ному исходу в предположении существования не более чем одной

фальшивой монеты), либо помечен одним из исходов :L, гН, G,

означающим соответственно, что монета с номером i является лег-

кой или тяжелой или что все монеты настоящие

Четко определив подлежащий дальнейшему рассмотрению класс

алгоритмов, мы можем теперь исследовать свойства, которыми

должно обладать каждое дерево из этого класса; мы можем также

задаться вопросом, как найти алгоритмы, являющиеся в некотором

смысле оптимальными Мы сделаем это в начале для чешрех монет,

а затем перейдем к общему случаю

Поскольку в задаче о четырех монетах требуется различить

девять возможных исходов, любое дерево решений дтя этой задачи

должно иметь по крайней мере девять листьев и, следовательно,

не менее двух ярусов Поэтому дерево на рис 1.6 является опти

мальным и в смысле худшего случая, и в среднем Существуют ли

другие оптимальные деревья? Для ответа на этот вопрос мы должны

рассмотреть множество всех деревьев решений для задачи о че-

тырех монетах Нашу задачу облегчит любое рассуждение, которое

позволит исключить из дальнейшего рассмотрения какую-либо

часть этого множества деревьев решений Прежде всего видно, что

путем любой перестановки множества {1, 2, , п} сомнительных

монет из одного дерева, приведенного на рис 1.6, можно получить

другие оптимальные деревья; все они будут изоморфны дереву па

рис 1 6 Исходя из этого, мы теперь уточним постановку задачи

и будем интересоваться попарно неизоморфными деревьями.

Зададимся затем вопросом, существует ли оптимальное дерево

среди тех, у которых в корне не используется монета с номером О

При таком ограничении в корне дерева можно сделать только два

различных сравнения, а именно 1:2 и 1, 2.3, 4 Рассмотрим раз-

биение исходов по трем ветвям, выходящим из корня, как показано

на рис 1 5 Для получения такого, как на рис 1.6, полного двухъ-

ярусного тернарного дерева, девять возможных исходов должны

были бы быть разбиты в отношении (3, 3, 3), они же вместо этого

разбиваются соответственно в отношении (2, 5, 2) и (4, 1, 4) Таким

образом, мы заключаем, что задачу для четырех монет нельзя ре-

шить за два сравнения, не используя дополнительную настоящую

монету

Наконец, рассмотрим те деревья решений, которые используют

монету 0 в корне В этом случае видно, что в корне фактически

возможны только два сравнения (0 • 1) и О, 1 : 2, 3 Для первого

сравнения набор исходов будет (1, 7, 1), в связи с чем все алгоритмы,

начинающиеся таким способом, для нас непригодны; набор же

исходов (3, 3, 3) приводит к оптимальному дереву, показанному на

рис 1 6 Аналогичным образом устанавливается, что для оптималь-

ного дерева сравнения в первом от корня ярусе определяются един-

ственным образом. Отсюда мы заключаем, что для задачи о четырех

монетах фактически существует только одно оптимальное дерево

Интересно посмотреть, что происходит, когда используемые

для анализа задачи о четырех монетах идеи переносятся на про-

извольный случай В некоторой степени все идеи обобщаются на

случай любого числа монет, однако некоторые из них нс имеют

практического значения, когда п значительно больше четырех

В принципе оптимальные деревья решений всегда можно найти

путем систематического поиска в множестве деревьев решении,

поскольку для любого заданного п в качестве кандидатов требуется

рассмотреть лишь конечное число деревьев решений В главе 4

мы обсудим технику исчерпывающего поиска в таких конечных

множествах Однако, если даже поиск организован разумно и рас-

сматриваются лишь существенно различные (не изоморфные) де-

ревья, эта процедура не может служить практическим способом

отыскания оптимальных деревьев решений С ростом п число де-

ревьев растет экспоненциально, и поэтому техника исчерпывающего

поиска имеет практическое значение только для малых значений п

Поскольку совершенно очевидно, что число листьев в дереве

решений должно быть по крайней мере таким же, как и число воз-

можных исходов задачи (2л+1 для задачи об п монетах), сразу же

можно получить нижнюю оценку необходимого числа сравнений

(или, что эквивалентно, верхнюю оценку числа монет для данного

числа сравнений)

Теорема 1.1 Если п>-^-(3‘—1), то задачу для и монет нельзя

решить за I сравнений в худшем случае.

В разд 2 3 3 мы воспользуемся той же идеей для доказательства

более сильного утверждения:

Теорема 1.2, Если n>-i-(3f—1), то задачу для п монет невоз-

можно решить за I сравнений в среднем

Заметим, что локальные данные о разбиении исходов по вет-

вям, выходящим из некоторого узла, позволяют делать выводы о

свойствах, присущих всему дереву решений. Мы воспользуемся

этим замечанием для получения трех общих результатов Ими

являются

1 Отрицательный результат относительно алгоритмов, которые

не используют настоящую монету О

2 Изящное утверждение, обратное теореме 1 1, которое уста

навливает, что в случае —1) для решения задачи об п мо-

нетах достаточно I сравнений, а также явное построение оптималь-

ных деревьев решений для п= ^-(Зг—1)

3 Эвристическое правило, позволяющее эффективно получать

хорошие (но не обязательно оптимальные) деревья решений, когда

указанное выше изящное решение для отыскания оптимальных

деревьев не пригодно

Теорема 1.3. Если n>y(3z—1), то задачу для п монет невоз

можно решить за / сравнений, не использхя монету О

Доказательство Из теоремы 1 1 следует, что достаточно только

показать, что если 2п+1=3(, то не существует I уровнего дерева

решений для задачи об п монетах в эгой ограниченной форме Для

некоторого /, в корне любого такого дерева мы сравни-

вали бы / монет с номерами, скажем, 1,2, , / с другим множе-

ством из / монет, пусть, к примеру, они имеют номера /+1, ,2/

(рис 1.7). Заметим, что каждой из ветвей с символом «С» и «>»

соответствует 2/ исходов, а оставшиеся 2л4-1—4/ исходов соот-

ветствуют ветви с символом «=» Для того чтобы можно было скон-

струировать нужное дерево решении с /=log3 (2/i-M) уровнями,

каждой из перечисленных выше ветвей должна соответствовать

треть исходов (почему3) Тогда имело бы место соотношение 2/ =

—2п-Н—4/ или эквивалентное ему соотношение 6/=2/1т1, что

для целых / и п невозможно, гак как 6/ четко, тогда как 2н+1 не-

четно

Стоит отметить утверждение, обратное тому, которое использо-

валось при доказательстве теоремы 1 3 если можно найти дерево,

такое, что в каждом узле множество возможных исходов делится

на три равные части, то это дерево должно быть оптимальным.

Эта идея является ключевой при доказательстве следующей тео-

ремы

Теорема 1.4. Если пСу(3'—1), то задачу для п монет можно

решить за I сравнений.

Доказательство Пусть Кг=(Зг—1). Рассмотрим случаи n=Ki

(случай n<Kt мы оставляем для упражнения 7) Поскольку в по-

следующем числа Ki играют важную роль, полезно отметить два

тождества:

2Kt + 1 = Зг

Заметим, что Xt=l и что для одной монеты п-Kt задачу можно

решить одним сравнением 0 : 1 Мы должны показать, что в общем

случае для К/ монет задачу можно решить за I сравнений, мы сде-

лаем это, указав алгоритм, который при любом заданном зна-

чении I можно использовать для построения необходимого для нас

дерева решений.

В процессе выполнения этого алгоритма мы аккуратно будем

следить за всеми сведениями о множестве монет, причем эта ин-

формация будет всегда принадлежать к одному из трех типов

В ходе работы алгоритма при любом значении I, изменяющемся

от I до 1, алгоритм всегда находится в одном из трех состояний

Состояние 1 мы имеем Л, подозрительных монет (т е. если в

рассматриваемом нами множестве существует фапьшивая

монета, то она находится именно среди этих монет), и нам

для окончания решения разрешается сделать i сравнений

Случай !— I соответствует начальному состоянию задачи

Состояние 2 мы имеем множество из К,+1 монет и другое мно-

жество из Ki монет; в нашем распоряжении имеется i срав-

нений, и мы знаем, что или в множестве из Хг+1 элементов

находится тяжелая монета, или в множестве из элемен-

тов находится легкая монета

Состояние 3 то же, что и состояние 2, но теперь мы знаем, что

или в множестве из /С+1 элементов находится легкая

монета, или в множестве из элементов находится тяжелая

монета.

Для каждого из этих трех состояний алгоритма мы указываем,

какое надлежит сделать следующее сравнение, с помощью функции

переходов /, показанной на рис 1 8, мы утверждаем, что предпи

санное действие будет всегда приводить нас к одному из тех же са-

мых состояний (при этом i убывает на единицу). Когда i примет

значение 1, задача решится единственным сравнением, как быдо

отмечено выше Алгоритм имеет следующую структуру

Рис

Для завершения доказательства остается проверить некоторые

детали Для каждого перехода в диаграмме состояний, приведен-

ной на рис 1 8, вы должны просто проверить согласование мно-

жеств монет в начальном и конечном состояниях Вы должны

также проверить, используя рекуррентное соотношение Кг=

= ЗХг-1+1, что возможные для каждого состояния исходы распа-

даются по трем ветвям, выходящим из этого состояния, на группы

одинаковой мощности

Для большинства комбинаторных задач не существует изящ-

ного и эффективного пути отыскания оптимального решения,

такого, как алгоритм I 5 для задачи о фальшивой монете В этом

отношении литература по комбинаторным алгоритмам зачастую

вводит читателя в заблуждение, поскольку она сосредоточивает

внимание на элегантных решениях, даже если они применяются

только к отдельным задачам Красивые решения часто страдают

большим пороком если задачу слегка изменить, решение стано-

вится неприменимым Такая ситуация возникнет, например, при

доказательстве теоремы 1.3, если в задаче о фальшивой монете

предположить существование по крайней мере двух фальшивых

монет вместо одной Идеи, устойчивые по отношению к небольшим

изменениям формулировки задачи, имеют общий характер, подобно

идее рассмотрения разбиения исходов по ветвям дерева решений,

Проиллюстрируем другое применение этой идеи.

Важный принцип практических вычислений утверждает, что

если точно решить задачу трудно, то следует попытаться найти

эвристический алгоритм, который позволит эффективно находить

приближенные решения В случае деревьев решений для задачи

с данным числом исходов очевидным эвристическим соображением

является следующее попытаться удержать число уровней в дереве

решений как можно меньшим. Этого можно достигнуть, если де-

рево делать как можно более широким Тернарное дерево решений

с данным числом листьев можно сделать широким, если в каждой

вершине исходы разбить на три группы примерно равной мощности

В случае задачи с четырьмя монетами при девяти возможных

исходах нам хотелось бы выбрать в корне такое сравнение, чтобы

на каждой из ветвей, выходящих из корня, оставались возможными

три исхода Однако, как мы видели, этого достичь невозможно,

есчи нам дополнительно не дана настоящая монета В такой ог-

раниченной постановке задачи с четырьмя моментами в корне можно

сделать только два существенно различных сравнения, а именно

1 2 и 1,2 : 3,4 Они разбивают девять исходов на части (2, 5, 2)

и (4, 1, 4) соответственно Какая из них более однородная, т е

ближе к идеальному разбиению (3, 3, З)2 Введем важную меру од-

нородности таких разбиений Мы не имеем возможности привести

здесь полное обоснование выбора этой специфической меры До-

полнительные соображения по этому поводу будут приведены в

гл 6 и 7

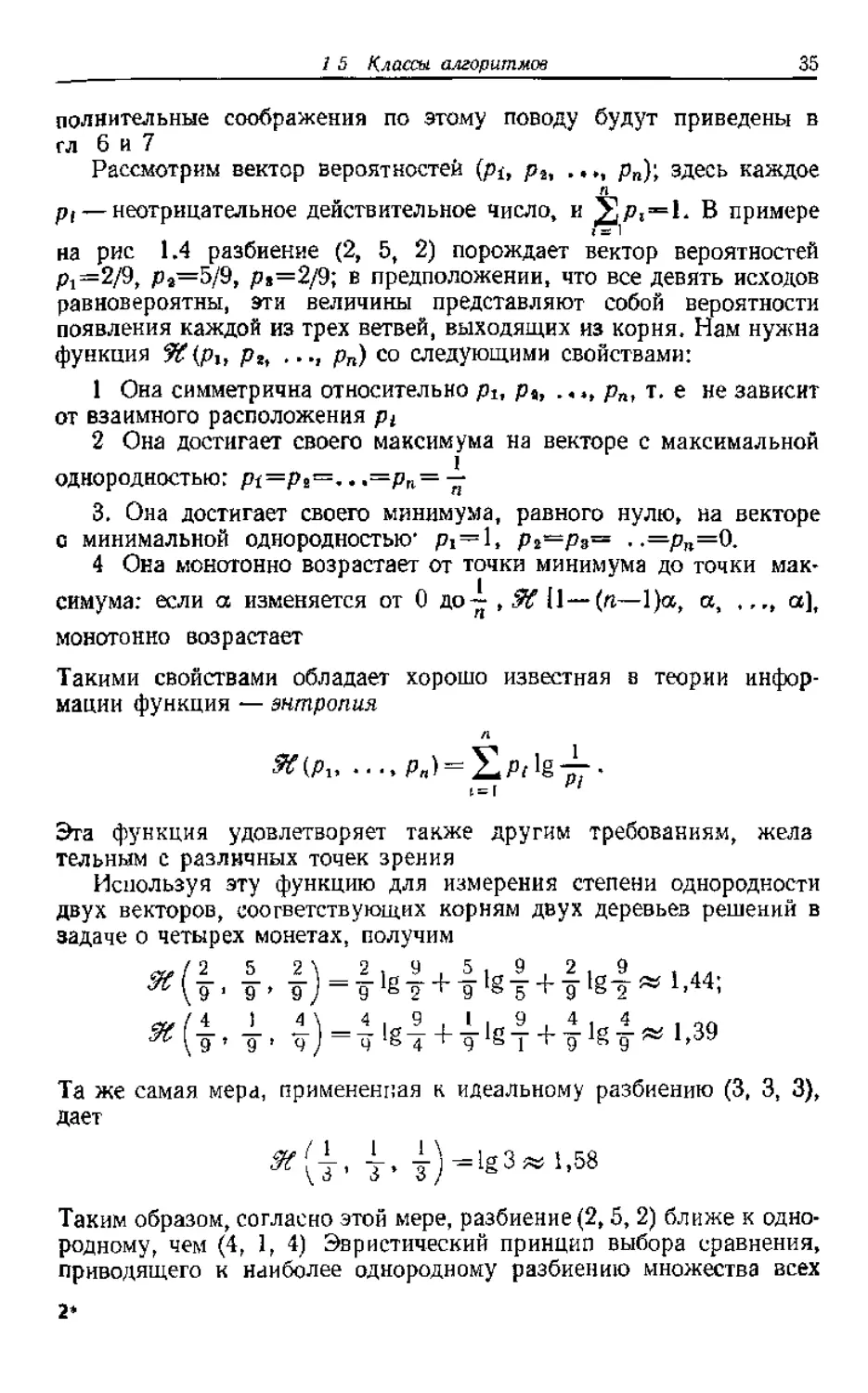

Рассмотрим вектор вероятностей (pi, рг, ..., рп); здесь каждое

pi — неотрицательное действительное число, и ® примере

на рис 1.4 разбиение (2, 5, 2) порождает вектор вероятностей

pj=2/9, ps=5/9, р»=2/9; в предположении, что все девять исходов

равновероятны, эти величины представляют собой вероятности

появления каждой из трех ветвей, выходящих из корня. Нам нужна

функция %?(plf рг, .... рп) со следующими свойствами:

1 Она симметрична относительно pi, pt, .... рп, т. е не зависит

от взаимного расположения pi

2 Она достигает своего максимума на векторе с максимальной

однородностью: pt=pi=.. .=рп= —

3 . Она достигает своего минимума, равного нулю, на векторе

с минимальной однородностью- Pi=l, Рг=Рз= ..=рп=0.

4 Она монотонно возрастает от точки минимума до точки мак-

симума: если а изменяется от 0 до—,5^11—(п—1)а, а, ,,,, а],

монотонно возрастает

Такими свойствами обладает хорошо известная в теории инфор-

мации функция — энтропия

Я{рх....

Эта функция удовлетворяет также другим требованиям, жела

тельным с различных точек зрения

Используя эту функцию для измерения степени однородности

двух векторов, соответствующих корням двух деревьев решений в

задаче о четырех монетах, получим

44-4, 4Н4+44+44-+39

Та же самая мера, примененная к идеальному разбиению (3, 3, 3),

дает

Таким образом, согласно этой мере, разбиение (2,5, 2) ближе к одно-

родному, чем (4, 1, 4) Эвристический принцип выбора сравнения,

приводящего к наиболее однородному разбиению множества всех

исходов, корректно устанавливает, что корнем паилучшего дерева

решений для ограниченной задачи о четырех монетах должно быть

сравнение 1 2, Поскольку большинство задач о наилучшем дерева

решении не имеет процедур отыскания оптимальных решений, от

личных от полного перебора, этот простой эвристический принцип

стоит помнить

В этой части мы продемонстрировали полезность точного оп

ределения класса алгоритмов Из простой идеи рассмотрения раз

биения множества исходов по ветвям дерена решений оказалось

возможным получить границы необходимого числа сравнений,

эффективный алгоритм построения оптимального дерева для спе

циального случая и ценный эвристический принцип, который при

меняется к любой задаче о дереве решений

1.6. АНАЛИЗ АЛГОРИТМОВ

В процессе разработки и реализации алгоритма естественным

образом раскрываются некоторые его свойства Например, из

описания алгоритма 1 3 в разд 1 1, очевидно, следует, что дво

ичный набор длины п ои обрабатывает за pign-] итераций. По

мере того как алгоритмы становятся все более и более сложными,

все менее и менее вероятно, что их важные свойства проявятся на

стадиях разработки и реализации Как правило, некоторые важные

аспекты поведения алгоритма, такие, как его корректность, не-

обходимое число операций или объем памяти, определить трудно

Поэтому обычно глубокое понимание нового алгоритма предваряет

очень длинная стадия его анализа

Из-за трудностей анализа алгоритмов им зачастую просто пре

небрегают, вместо этого программа выполняется, чтобы увидеть

что получится (например, измеряется время работы) Такой подход

можно признать удовлетворительным, если есть основание пола

гать, что тестовые задачи достаточно хорошо характеризуют ра

боту алгоритма и в общем случае, если же Это не так, то описанный

выше подход даст мало ценной информации Даже если тест пре

красно характеризует работу алгоритма, он никогда не даст ответ

на придирчивый вопрос, могут ли существовать лучшие алгоритмы

для решения той же самой задачи. Проблему оптимальности алго

ритма можно решить только путем его анализа

В анализе алгоритмов существуют две фундаментальные про

блемы

1. Какими свойствами обладает данный алгоритм5

2 Какие свойства должен иметь любой алгоритм, решающий

данную проблему5

Фундаментальная разница между этими дв>мя вопросами состоит

в подходе к ответу на них В первом случае алгоритм задан и за

37

ключения выводятся путем изучения свойств, присущих ему.

Во втором случае задается проблема и точно определяется струк-

тура алгоритма, заключения выводятся на основе изучения суще-

ства проблемы по отношению к данному классу алгоритмов

Обсуждение задачи о фальшивой монете в разд 1 5 содержит

примеры обоих типов проблем в ситуации, когда решить их можно

сравнительно легко В этой главе мы продолжим изучение кодов»

сохраняющих разности, для того, чтобы привести нетривиальные

примеры анализа отдельного алгоритма и класса всех алгоритмов,

предназначенных для решения данной проблемы

Анализ алгоритма построения кода. Рассмотрим алгоритм, ко-

торый порождает последовательность £2>г, кодов, сохра-

няющих разности, начиная с произвольного кода и который

строит S>t путем композиции с самим собой согласно проце-

дуре увеличения ранга, изложенной в разд 1.3 Вычислим ранг

кода построенного по такому алгоритму, считая его функцией

длины кодового слова. Пусть R (п) — ранг п разрядного кода

и соответственно R(2n)— ранг кода S>i + 1, полученного компо-

зицией кода S)i с самим собой Тогда из уравнения (1 1) разд 1.3

мы знаем, что

Для того чтобы определить вид функции, удовлетворяющей этому

уравнению и, в частности, скорость роста его решения, упростим

правую часть (не слишком сильно ее изменяя) и изучим видоизме-

ненное функциональное уравнение

г(2«) = Ш^, (12)

надеясь, что г (я) не слишком сильно отличается от R (п) В упраж-

нении И поставлена задача выяснить, насколько хорошо г (и)

аппроксимирует R(n)

Систематические процедуры решения таких рекуррентных урав-

нений более подробно обсуждаются в гл 3, но в данном случае

достаточно метода проб и ошибок. После некоторого эксперимен-

тирования мы придем к экспоненциальному решению вида

r(n) — c2an,

где с и а— константы, которые надлежит определить Подставляя

это предполагаемое решение в 1 2, получим уравнение

c2ian =!

которое удовлетворяется, если c=t~\ 1, независимо от значения а.

Таким образом, алгоритм, увеличивающий ранг, строит коды с

рангами, которые приближенно имеют вид

Само рекуррентное уравнение не ограничивает выбора а, но

существует другое ограничение, которое должно быть удовлетво-

рено, а именно начальные условия, ранг и длина кода ®0, с кото-

рого начиналась схема композиции. Если в качестве мы выберем

оптимальный четырехразрядный DP-I-код ранга 8, то получим на-

чальное условие

г(4) = 8 = ;

из которого вытекает а= у, и, следовательно

Таким образом, алгоритм, увеличивающий ранг, начинающийся с

этого частного кода строит «-разрядные коды, имеющие около

+ 1 кодовых слов из 2п возможных двоичных наборов длины п

Сформулировать этот результат можно, например, так Только

половину разрядов в коде можно использовать для информации;

другая половина определяется частично задачей (условием, что

код должен сохранять разности) и частично рамками, устанавли-

ваемыми процедурой увеличения ранга

Можно ли сделать лучше? Можно ли найти алгоритмы, которые

строят «-разрядные коды, ранги которых более близки к 2я? К этому

вопросу можно подойти двумя различными путями Один очевид-

ный — постараться улучшить данный алгоритм Более тонкий

подход состоит в том, чтобы сначала посмотреть, можно ли добиться

улучшения Прежде чем обсуждать более тонкий подход, кратко

остановимся на первом

В нашем примере можно получить частичное улучшение, если

начать процедуру увеличения ранга с более эффективного кода

Например, оптимальный 5-разрядный DP-1-код ранга 14 дает г(5)=

= 14=2-260 или а= у lg7«0,56, что уже несколько лучше Однако

уравнение (1 3) с учетом того, что а<1 (ранг кода длины п, оче-

видно, не может превзойти 2"), говорит нам, что в любом коде,

построенном на основе применения алгоритма увеличения ранга,

долю длины кодового слова, равную (1—а), нельзя использовать

для записи информации. Для тою чтобы получить более сущест

венное улучшение, мы должны отказаться от описанной процедуры

увеличения ранга и исследовать другие принципы построения ко-

дов Мотивировкой таких обширных исследований служит резуль-

тат следующего анализа.

39

Верхняя граница ранга (гг,/)-кодов. Требования, предъявляемые

к кодам, сохраняющим разности;

1) если |t—то H(D„ Dj)=]i—/], и

2) если |t—/|>/, то H(Dit

вынуждают кодовые слова Di находиться на определенных мини-

мальных расстояниях друг от друга, а это обстоятельство в свою

очередь не дает возможности использовать все вершины «-мерного

куба в качестве кодовых слов «-разрядного кода Это явление

проиллюстрировано на рис. 1 2 В данном разделе мы выведем

верхнюю оценку ранга «-разрядного DP-1-кода, имея лишь его

определение и ничего более не предполагая. Следовательно, эта

оценка, которая зависит только от самой задачи, должна иметь

место для любого алгоритма построения кода

Верхняя оценка ранга N «-разрядного DP /-кода, которую

мы получим, имеет следующий вид:

£.c2nr,

где с зависит от I и не зависит от п Правая часть этого неравенства

растет значительно быстрее, чем оценка >•(«)= (/-J-l)2°", <з>1,

которая была получена из уравнения (1 3) для кодов, построенных

в соответствии с процедурой увеличения ранга. Расхождение

между этой верхней оценкой и нижней оценкой, которую дает

уравнение (1.3), оставляет большую неопределенность в том, какие

же ранги достижимы, иначе говоря, остается неясным, завышена

ли верхняя оценка или не эффективна процедура увеличения

ранга. Эта неопределенность в исследуемой задаче является ти-

пичной ситуацией. Наша задача слишком специальна, чтобы про-

должать здесь дальнейшее обсуждение Скажем только, что верх-

няя оценка достаточно хорошая и что можно построить коды с

рангами, близкими к верхней оценке Для дальнейшего ознаком-

ления можно рекомендовать литературу, указанную в разд 1 7.

Здесь же мы намеревались только очертить проблемы, которые

необходимо преодолеть при анализе нетривиальных алгоритмов.

Мы изложим только схему вывода неравенства (1.4), оставляя

читателю возможность самому заполнить пробелы в доказательстве.

Доказательство неравенства 1.4. Пусть Dt, .DN}—

«-разрядный DP-Z-код; отождествим кодовые слова Dc с вершинами

«-мерного куба, как показано на рис. 1.2. Положим

и каждой вершине V «-мерного куба сопоставим вес (V), равный

числу кодовых слов, которые находятся на хемминговом расстоянии

г от вершины V:

WT (И)=(число кодовых слов D,, таких, что H(V,

Сначала покажем, что

1ГГ (V)^zi,

D 0 1 t О

1 0 1 0 t

110 11

и проверим, что

1 Каждая строка имеет точно г единиц, и отсюда общее число

единиц в матрице равно sr,

2 , В каждом столбце матрицы находится по крайней мере г

единиц (проверка этого утверждения предлагается в упражнении

12), и, следовательно, общее число единиц в матрице не превосходит

Сопоставляя эти два утверждения, получаем, что зг^пг, или s^n.

(Как будет показано в разд 3 4,2, простой прием подсчета эле-

ментов матрицы по строкам и столбцам и приравнивания этих

результатов заходит удивительно далеко )

Установив, что 1УГ(К)С«, отметим теперь следующие свой-

ства распределения весов в л-мерном кубе

1 Общий вес в кубе равен N (?), поскольку каждое из У ко-

довых слов дает вклад i в вес каждой из (") вершин, находящихся

на расстоянии г от кодового слова;

2 Общий вес кодовых слов Dt равен 2(W—г) (упражнение 13),

и отсюда общий вес всех вершин, не принадлежащих коду ££>,

3 Поскольку существует 2"—W вершин V, не принадлежащих

и каждая из них имеет вес Ц7Г (К)й^/?, общий вес всех вершин,

не принадлежащих S>, не превосходит (2’—Afjzi.

Объединяя (2) и (3), получаем неравенства

N -2 (Л/ -г) С (2й — /V) и

п2"—2г.

Для фиксированного г и растущего п величина (?) растет при-

мерно как Ьпг, где b зависит от г и не зависит от п. Учитывая это,

можно показать, что

а это соотношение и есть неравенство (1 4)

Читатель, который старательно проработал эту главу, начи-

ная с тривиального алгоритма подсчета числа единиц в наборе»

просматривающего все разряды по очереди, и кончая заполнением

пробелов в выводе верхней оценки (1.4), имеет теперь общее пред-

ставление о полном спектре комбинаторных алгоритмов. В част-

ности, каждая тема, встречающаяся в этой книге, будет некоторым

напоминанием принципов разработки алгоритмов, приведенных

в разд. 1 3 и 14, рассмотрения проблем реализации, приведенных

в разд. 1 1 и 1 2, и математических процедур анализа алгоритмов,

изложенных в разд 1 5 и 1.6.

1.7. КОММЕНТАРИИ И ССЫЛКИ

Хотя комбинаторная математика является старой дисциплиной

(она получила свое наименование в 1666 г от Лейбница и его Dis-

sertatio de Arte Combinatorial, комбинаторные алгоритмы с их

акцептом на разработку, анализ и реализацию практических алго-

ритмов являются продуктом века вычислительных машин Ссылки

на первые работы, касающиеся специальных вопросов этой области,

будут лапы в последующих главах, но список работ, носящих более

общий характер, приводится ниже

Lehmer D Н Combinatorial Problems with Digital Computers,

Proc Fourth Canadian Math Congress, 1957, University of

Toronto Press, 1960, 160—173.

Lehmer D. H Teaching Combinatorial Tricks to a Computer, Chapter

15 in Combinatorial Analysis, R Bellman and M Hall (eds),

Proc. Symp Applied Math , Vol 10, American Math. Society,

Providence, R. I , I960, 179—193

Lehmer D. H. The Machine Tools of Combinatorics, Chapter 1 in

Applied Combinatorial Mathematics; E F Beckenbach (Ed),

Willey, New York, 1964, 5—31

Hall M , Knuth D. E Combinatorial Analysis and Computers, Ame-

rican Math Monthly, 72, Pt II (1965), 21—28

Укажем более современные руководства

Wells М. В Elements of Combinatorial Computing, Pergamon Press,

Oxford, 1971

Even S Algorithmic Combinatorics, Macmillan, New York, 1973

Aho A V , Hopcroft J. E , Ulman J D The Design and Analysis

of Computer Algorithms, Addison-Wesley, Reading, Mass., 1974

[Имеется перевод: Ахо A , Хопкрофт Дж, Ульман Дж Пост-

роение и анализ вычислительных алгоритмов.— М : Мир, 1979 |

Nijenhuis А , Wilf II S. Combinatorial Algorithms, Academic Press,

New York, 1975

Обширные сведения по комбинаторным алгоритмам можно найти

в книге

Knut D Е The Art of Computer Programming, Vol 1, Fundamental

Algorithms (1968), Vol 2, Semmumerical Algorithms (1969),

Vol 3, Sorting and Searching (1973), Vol 4, Combinatorial

Algorithms (to appear), Addison-Wesley, Reading, Mass [Имеет-

ся перевод. Кнут Д. Искусство программирования для ЭВМ,

т 1, 2, 3 —М Мир, 1976, 1977, 1978.]

Логарифмический алгоритм суммирования единиц в двоичном

наборе, приведенный в разд 1 1, был, вероятно, получен неза-

висимо несколькими авторами. Одним из первых его реализовал

Давид Мюллер из Иллинойсского университета, который исполь-

зовал этот алгоритм в программе для машины Illiac I в 1954 i

Описанные в разд 1 2 коды, сохраняющие разности, или не-

значительные их вариации известны под различными названиями

(цепные коды, циклические коды) с тех пор, как в работе

Kautz W Н Unit-Distance Error-Checking Codes, IRE Trans.

Electronic Computers, EC-7 (1958), 179—180

был рассмотрен специальный случай /=1 Эта работа, как и неко-

торые последующие, касается приложений таких кодов к задачам

обнаружения и исправления ошибок, в особенности при представ-

лении непрерывных сигналов цифровыми Обсуждение проблем

применения кодов, сохраняющих разности, к задачам распозна-

вания, а также соо1ветствующая библиография приведены в работе

1 8 Упражнения

Preparata F. P., Nievergelt J. Difference-Preserving Codes, IEEE

Trans. Information Theory, IT-20 (1974), 643—649

Анализ задачи, более общей, чем рассмотренная в разд I 6

задача о фальшивой монете, приводится в работе

Smith С. А В The Counterfeit-Coin Problem, The Mathematical

Gazette, 21 (1947), 31-39

Проблема анализа комбинаторных алгоритмов привлекла за

последнее время много внимания. Приведем две обзорные статьи,

посвященные этой теме

Knuth D. Е. Mathematical Analysis of Algorithms, Information

Processing 7i (Proceedings of the 1971 1FIP Congress), North-

Holland Publishing, Co , Amsterdam, 1972, 19—27.

Frazer W. D Analysis of Combinatory Algorithms — A Sample of

Current Methodology, Spring Joint Computer Conference, AFIPS

Conference Proceedings, Vol. 40 (1972), 483—491.

1.8. УПРАЖНЕНИЯ

этом\олжно выполняться следующее условие: па каждом стержне ни в^какой

для попечения (nH 1) разрядного DP-1-кода ранга

к алгоритму, требующему я—1 сложений.

11 Эта задача касается оценки различия между апnj оксимацией г (п) и фуьк-

(а) Покажите что для любого целого/>1 и любого начального условия /?(!)=

—с^1 функция Rin) монотонно возрастает.

всех л>1 выполняется неравенство R(п)^г(л).

(с) Рассмотрите рекуррентную формулу

Покажите, что при одинаковых начальных условиях R(1)W(1)^1 пя всех

п>\ выполняется неравенство R(n)<r(n)

(d) Найдите компактное выражение для решения г(п) рекуррентного срав

ошибки аппроксимации г (п) функции R (п) Определите скорость роста этой гра

13 Покажите, что для DP-f-кода ранга Л'и для

Глава 2. Представление комбинаторных

объектов

Большинство вычислительных устройств в качестве основных

объектов допускает только двоичные наборы, целые и символы,

поэтому, прежде чем работать с более сложными объектами, их

необходимо представить двоичными наборами, целыми или сим-

волами Например, числа с плавающей запятой кодируются парой

целых — мантиссой и порядком этого числа, но такое кодирование

обычно незаметно для пользователя. В противоположность этому

рассмотренные в данной главе способы кодирования объектов (мно-

жества, последоватетьности и деревья) почти всегда адресованы

пользователю.

Любой заданный класс объектов может иметь несколько возмож-

ных представлений, и выбор наилучшего из них решающим обра-

зом зависит от того, каким образом объект будет использовав,

а также от типа производимых над ним операции Все эти сооб-

ражения побуждают пас рассмотреть не только свойства самих

представлений, но также и некоторые приложения.

2.1. ЦЕЛЫЕ

Целые являются основными объектами в вычислительной ком-

бинаторике, и хотя их легко можно использовать во всех вычисли-

тельных устройствах, иногда удобно представлять их в форме,

отличном от непосредственно заданной в машине В различных

вычислительных теоретико-числовых исследованиях изучаются са-

ми целые числа, но мы будем использовать их главным образом

при подсчете и индексировании В последнее время установлено,

чю полезны различные представления В этом разделе мы обсудим

важный и общий класс позиционных представлений, оставляя

ipyi-ие более специальные случаи для упражнений 4, 5 и 6.

Мы будем рассматривать только неотрицательные целые О, 1,

2, , поскольку, вообще говоря, при подсчетах и индексировании

нет необходимости в отрицательных целых Кроме того, к любому

представлению неотрицательных целых легко присоединить оди-

ночный знаковый двоичный разряд.

Позиционные системы для представления целых чисел очень

широко известны, поскольку они встречаются во многих разделах

46

математики, начиная с «новой математики» и кончая углубленным

курсом теории чисел. В системе счисления с основанием г каждое

положительное целое число имеет единственное представление в

виде конечной последовательности

в которой каждое dt — целое, удовлетворяющее условию

и dh=?M). Нуль представляется последовательностью (0). г назы-

вается основанием системы (г>1) Целое, соответствующее после-

довательности (2 1), имеет вид

N — d0 -Ed/?4-dar34-... 4-dsr*,

что принято выражать следующим образом-

На протяжении истории использовались различные значения г

Например, древние вавилоняне использовали г=60, а индейцы

племени майя г—20 Сегодня наиболее широко используется г=

= 10 — десятичная система, которую мы унаследовали от арабов,

и г=2— двоичная система, которая лежит в основе современных

вычислительных устройств В действительности она используется

лишь на самом низком уровне аппаратного оборудования, в слож

ных вычислительных устройствах и базисных языках удобнее

использовать г=8 или г=16

Единственность этого представления можно доказать методом

от противного Числа М=0 и N= 1, очевидно, имеют единственное

представление. Предположим, что представление не единственно,

и пусть V>1 будет наименьшим цепым числом, имеющим два

различных представления

Если то без потери общности предположим, что k>l. Тогда,

поскольку

и поскольку мы заключаем, что

ИА-1 (fA-, (2 21

что невозможно Таким образом, мы должны иметь k-l. Анало

гично, если мы имели бы снова неравенство (2 2) и отсюда

С необходимостью dk—ek. Следовательно, число

2 I Це we

имеет два различных представления, что противоречит предполо-

жению, что N — наименьшее из таких чисел

Для доказательства того, что каждое положительное целое

имеет представление по основанию г, достаточно задать алгоритм,

конструирующий (с необходимостью единственное) представление

данного числа W Как мы увидим, такую процедур} осуществляет

алгоритм 2 1 Он строит последовательность d„, di, d2, dh путем

повторения деления на г и записи остатков Пусть на первом шаге

при делении N на г остаток будет d« Частное, полученное в резуль-

тате первого шага, делим на г, вновь полученное частное делим

на г и т. д Полученная в результате такого процесса последова-

тельность остатков и будет требуемым представлением Л/ по ос-

нованию г.

Очевидно, что последовательность d0, db , dh, вычисленная

посредством применения алгоритма 2 1, для всех d, удовлетворяет

условию Os^di<r и dft=#0, за исключением случая ЛГ^О Простым

методом индукции можно показать, что ^=^d/,

Важным обобщением систем счисления с основанием г являются

смешанные системы счисления, в которых задается не единственное

основание г, а последовательность оснований ra, rt, г2, , и по-

следовательность (2 1) соответствует целому

где теперь каждое d, удовлетворяет неравенству 0^/{<гг и d^O,

если М=#0 Тот факт, что каждая такая последовательность соот-

ветствует единственному числу и каждое положительное целое

число имеет единственное представление, следует из простого обоб-

щения результатов для обычных систем счисления, которые яв-

ляются частным случаем смешанных систем при r^—r, i^O

Смешанные системы счисления могут вначале показаться стран-

ными, но в действительности в повседневной жизни они встреча-

48

ются почти так же часто, как и десятичные. Рассмотрим, напри-

мер, нашу систему измерения времени — секунды, минуты, часы,

дни недели и годы Это — в точности смешанная система с го=6О,

В главе 5 мы будем использовать некоторые смешанные системы

для установления соответствия между перестановками и целыми

числами В частности, мы будем использовать систему счисления

с факториалами, в которой последовательность (2 1) соответствует

петому числу

O<d,<t+I и <4=т±0для всех Л^О, заметим, что всегда d9=0 Это —

смешанная система счисления, в которой — Для фиксиро-

ванного значения n>k мы будем использовать также систему

счисления с убывающими факториалами, в которой последователь-

ность (2 I) соответствует целому числу

i и для в этом случае всегда dn-i=0 Это —

смешанная система счисления, в которой rt^=n—i,

Представление целого Л' в смешанной системе счисления (г0,

г,, . ) осуществляется с помощью алгоритма 2.2, который являет-

ся простым обобщением алгоритма 2.1. Вместо того чтобы для

получения dj, в качестве делителя всегда использовать г, в алго-

ритме 2 2 используются

2.2. ПОСЛЕДОВАТЕЛЬНОСТИ

Бесконечная последовательность

формально определяется как функция /, областью определения

которой является множество положительных целых чисел

Z>1. Во многих случаях индексирование последовательности более

удобно начинать с нуля; тогда областью определения / будет мно-

жество целых неотрицательных чисел. Аналогично определим ко-

нечную последовательность или список

как функцию, областью определения которой является множе-

ство {!, 2, ?г} Примером бесконечной последовательности

явтяются простые числа

i 1234 5 6 7 8 9 10..

Pi 2 3 5 7 11 13 17 19 23 29

перестановка

П (1, 2, 3, 4, 5, 6)= <6, 2, 5, 1, 3, 4)

2.2.1. Последовательное распределение

С вычислительной точки зрения простейшим представлением

конечной последовательности является точный список ее членов,

расположенных по порядку в последовательных ячейках памяти

Так, Si хранится, скажем, начиная с ячейки /t, st хранится, начи

ная с ячейки It—li+d, ss хранится, начиная с ячейки 4-2d

и т. д., где d— число ячеек, требуемых для хранения одного эле

мента последовательности. Это последовательное представление

проиллюстрировано на рис. 2.1

Описанное выше представление последовательности имеет ряд

преимуществ Во-первых, оно легко осуществимо и требует не-

больших расходов в смысле памяти. Кроме того, оно зачастую

еще полезно и потому, что существует простое соотношение м^жлу

i и адресом ячейки, в которой хранится s,-

Это соотношение позволяет организовать прямой доступ к любому

элементу последовательности. Наконец, последовательное пред-

ставление имеет достаточно широкий диапазон и включает в себя в

качестве специального случая представление многомерных мас-

сивов (упражнение 7)

Например, чтобы представить массив размером пХт

(2.4)

будем рассматривать его как последовательность Si, $2, sn,

в которой каждое s, в свою очередь является последовательностью

из т элементов i'-й строки нашей матрицы. Таким образом, число

ячеек, требуемых для записи элемента s, (будем обозначать это

число символом d), равно md, 1де d — число ячеек, требуемых

для записи элемента ац Поскольку последовательность Sj начи-

нается в ячейке

ячейка для atJ б\дет иметь стедующий адрес.

Это представление известно как построчная запись матрицы, по-

столбцовая запись получается, если массив (2 4) рассматривать как

последовательность tL, t2, , im, в которой каждое tt в свою оче-

редь является последовательностью из п элементов i го столбца

матрицы.

Последовательное распределение, наряду с преимуществами,

имеет некоторые значительные недостатки Например, такое пред-

ставление становится неудобным, если требуется изменить после-