Автор: Васильев Ф.П.

Теги: математика учебные пособия и учебники по математике задачи по математике высшая математика

ISBN: 978-5-9916-6157-7

Год: 2015

Текст

БАКАЛАВР • МАГИСТР

Под редакцией Ф. П. Васильева

МЕТОДЫ

ОПТИМИЗАЦИИ

УЧЕБНИК и ПРАКТИКУМ

\

^Ч

II НИ ||„т..II ИИ И

МОСКОВСКИЙ

ГОСУДАРСТВЕННЫЙ

УНИВЕРСИТЕТ имени

М. В. ЛОМОНОСОВА

Еюрэйт

издательство

УМО ВО рекомендует

biblio-online.ru

МОСКОВСКИЙ ГОСУДАРСТВЕННЫЙ

УНИВЕРСИТЕТ имени М. В. ЛОМОНОСОВА

МЕТОДЫ

ОПТИМИЗАЦИИ

УЧЕБНИК И ПРАКТИКУМ

ДЛЯ БАКАЛАВРИАТА И МАГИСТРАТУРЫ

Под редакцией профессора,

доктора физико-математических наук Ф. П. Васильева

Рекомендовано Учебно-методическим отделом

высшего образования в качестве учебника для студентов

высших учебных заведений, обучающихся по естественнонаучным

направлениям и специальностям

Книга доступна в электронной библиотечной системе

biblio-online.ru

kMd

Москва- Юрайт-2016

УДК 51-3(075.8)

ББК 22.1я73

М54

Ответственный редактор:

Васильев Федор Павлович — профессор, доктор физико-математических наук,

профессор кафедры оптимального управления факультета вычислительной

математики и кибернетики Московского государственного университета имени М. В.

Ломоносова.

Авторы:

Потапов Михаил Михайлович — профессор, доктор физико-математических наук,

профессор кафедры оптимального управления факультета вычислительной

математики и кибернетики Московского государственного университета имени М. В.

Ломоносова;

Будак Борис Александрович — кандидат физико-математических наук,

преподаватель кафедры оптимального управления факультета вычислительной математики

и кибернетики Московского государственного университета имени М. В. Ломоносова;

Артемьева Людмила Анатольевна — кандидат физико-математических наук,

преподаватель кафедры оптимального управления факультета вычислительной

математики и кибернетики Московского государственного университета имени М. В.

Ломоносова.

Рецензенты:

Арутюнов А. В. — доктор физико-математических наук, профессор, заведующий

кафедрой нелинейного анализа и оптимизации факультета физико-математических

и естественных наук Российского университета дружбы народов;

Куржанский А. Б. — академик Российской академии наук, доктор

физико-математических наук, заслуженный профессор Московского государственного университета

имени М. В. Ломоносова.

Методы оптимизации : учебник и практикум для бакалавриата и магистратуры /

М54 под ред. Ф. П. Васильева. — М.: Издательство Юрайт, 2016. — 375 с. — Серия :

Бакалавр и магистр. Академический курс.

ISBN 978-5-9916-6157-7

В учебнике излагаются наиболее известные и часто используемые на практике

методы поиска экстремума (максимума, минимума) функций конечного числа

переменных, объясняются идейные, эвристические соображения, лежащие в основе

каждого метода, исследуется их сходимость, обсуждаются вычислительные аспекты,

области применимости методов, их достоинства и недостатки. Рассмотрены также

методы решения задач оптимального управления процессами, описываемыми

системами обыкновенных дифференциальных уравнений. Основной текст книги

соответствует типовой программе для бакалавров. Выделенный звездочками

дополнительный текст рассчитан на обучающихся в магистратуре и читателей, заинтересованных

в углубленном изучении предмета. Учебник содержит достаточно большое

количество разобранных примеров и упражнений для самостоятельной работы студентов.

Соответствует актуальным требованиям Федерального государственного

образовательного стандарта высшего образования.

Для бакалавров и магистров технических вузов.

УДК 51-3(075.8)

ББК22.1я73

т-^J/^* Все права защищены. Никакая часть данной книги не может быть воспроизведена

I Ж в какой бы то ни было форме без письменного разрешения владельцев авторских прав.

Delphi Law Сотралу Правовую поддержку издательства обеспечивает юридическая компания «Дельфи».

© Коллектив авторов, 2015

ISBN 978-5-9916-6157-7 © ООО «Издательство Юрайт», 2016

Оглавление

Обозначения 7

Предисловие 11

Глава 1. Введение в оптимизацию. Классический метод 15

1.1. Постановка задачи 15

1.1.1. Задача минимизации 15

1.1.2. Задача максимизации 20

1.2. Теоремы Вейерштрасса 22

1.2.1. Классическая теорема 22

1.2.2. Обобщенная теорема Вейерштрасса 25

1.2.3. Теорема Вейерштрасса для некомпактных множеств 30

1.3. Задачи безусловной оптимизации. Классический метод 32

1.3.1. Описание метода 32

1.3.2. Примеры 38

1.4. Задачи на условный экстремум. Правило множителей Лагранжа 40

1.4.1. Постановка задачи. Необходимое условие оптимальности

на выпуклом множестве 40

1.4.2. Правило множителей Лагранжа в задачах с ограничениями

типа равенств 43

1.4.3. Правило множителей Лагранжа в общем случае 45

1.4.4. Достаточные условия оптимальности 47

1.4.5. Примеры 50

1.4.6. Экономический смысл множителей Лагранжа 60

1.5. Метод штрафных функций 61

1.5.1. Описание метода 61

1.5.2. Сходимость метода 64

1.5.3. Недостатки и достоинства метода 69

1.6. Обоснование правила множителей Лагранжа 70

1.7. Вспомогательные предложения 73

1.7.1. Формулы конечных приращений 73

1.7.2. Леммы о числовых последовательностях 75

Упражнения 76

Глава 2. Линейное программирование 81

2.1. Постановка задачи 81

2.1.1. Общая задача линейного программирования 81

2.1.2. Примеры 83

2.1.3. Каноническая задача 85

2.1.4. Основная задача 86

3

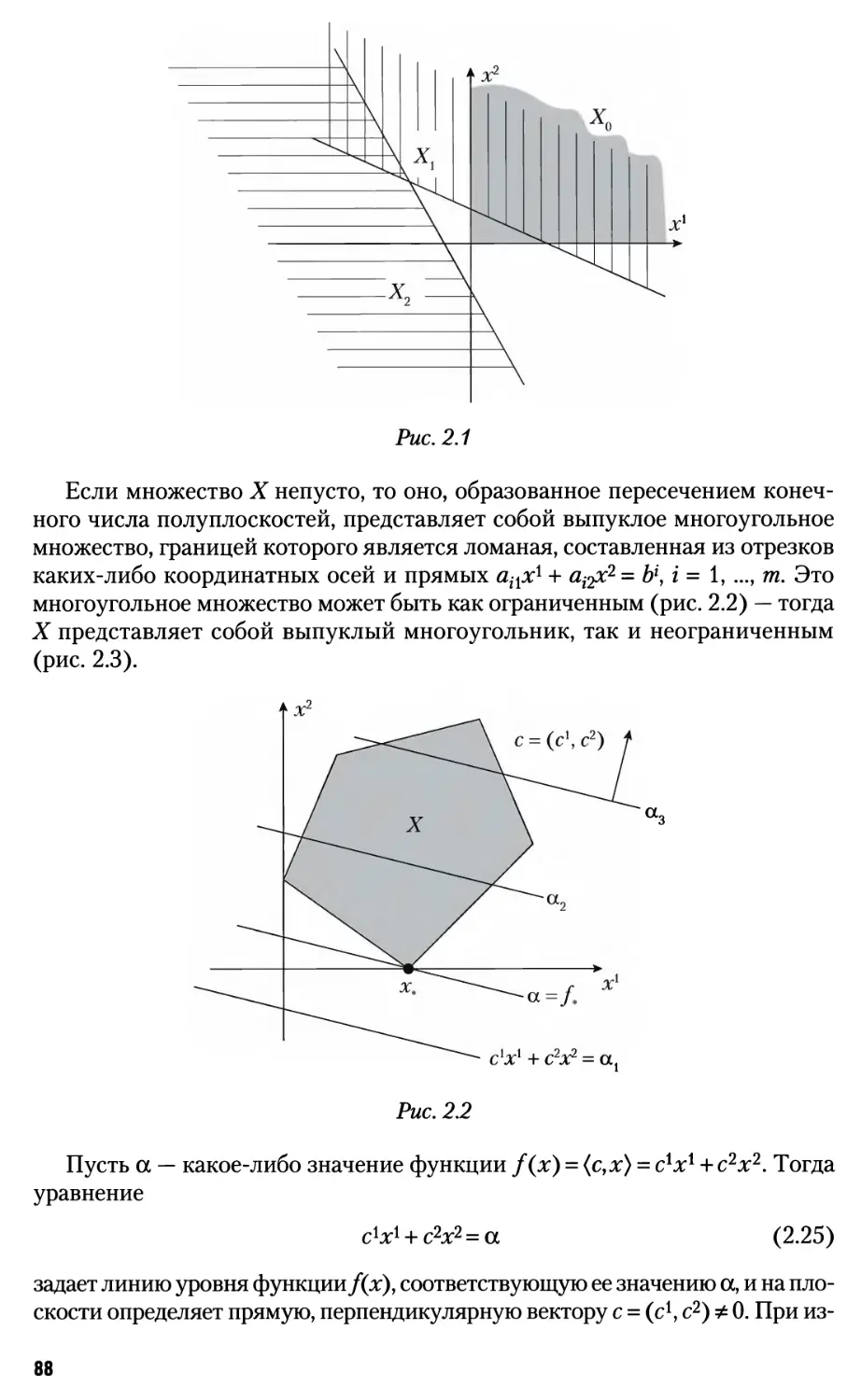

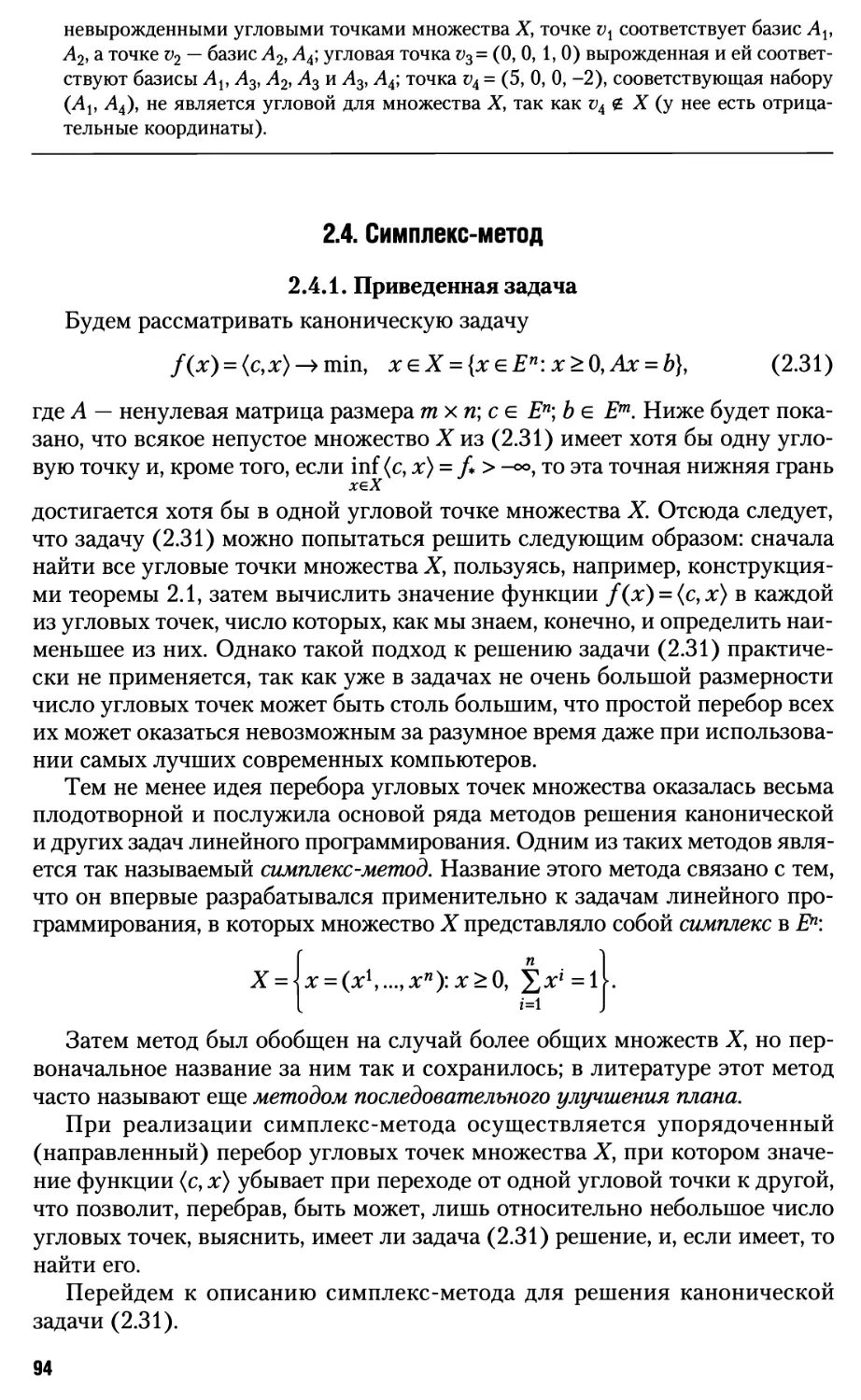

2.2. Геометрическая интерпретация задачи линейного программирования 87

2.3. Угловые точки в канонической задаче 91

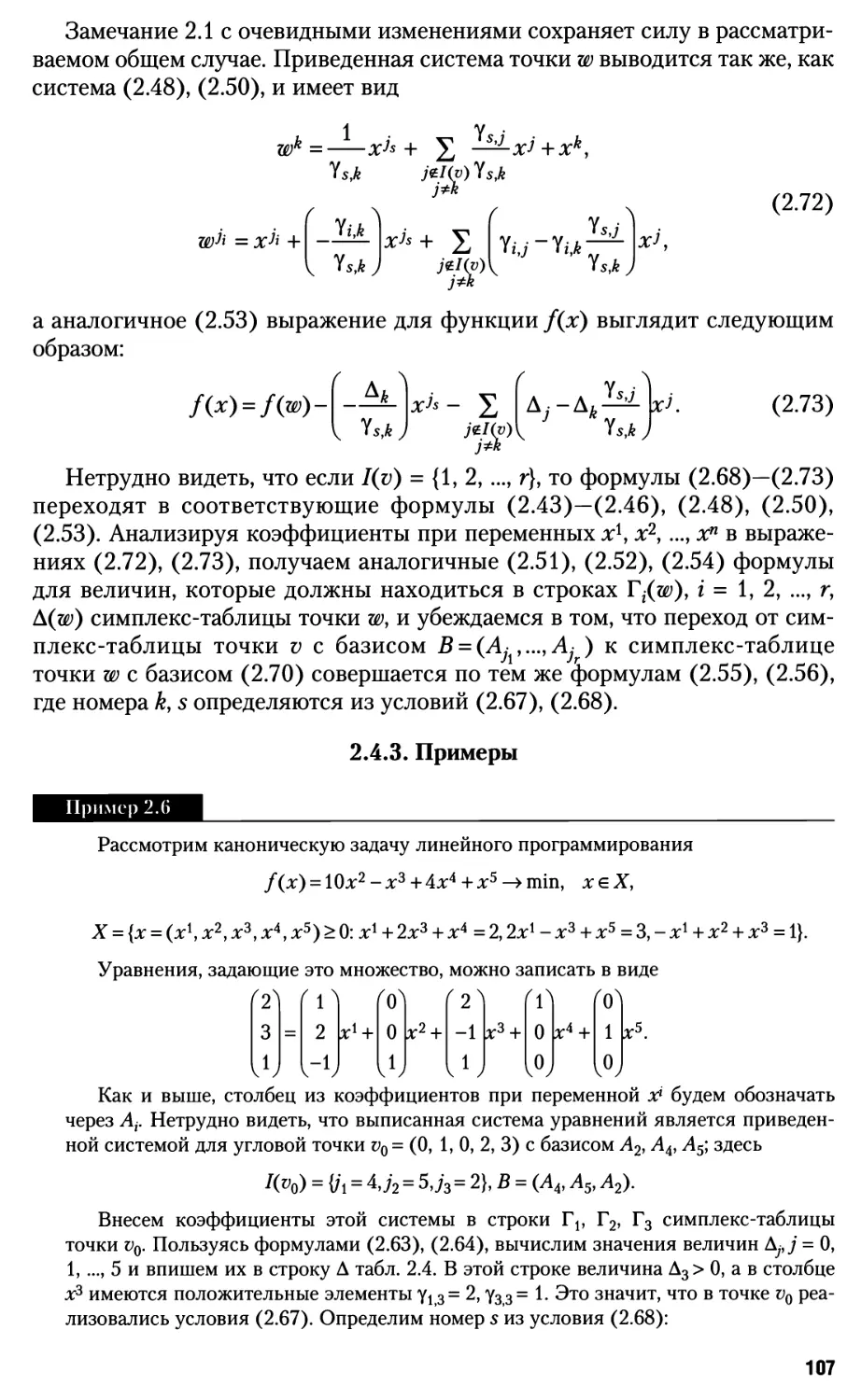

2.4. Симплекс-метод 94

2.4.1. Приведенная задача 94

2.4.2. Описание симплекс-метода 97

2.4.3. Примеры 107

2.4.4. Конечность метода в невырожденной задаче 109

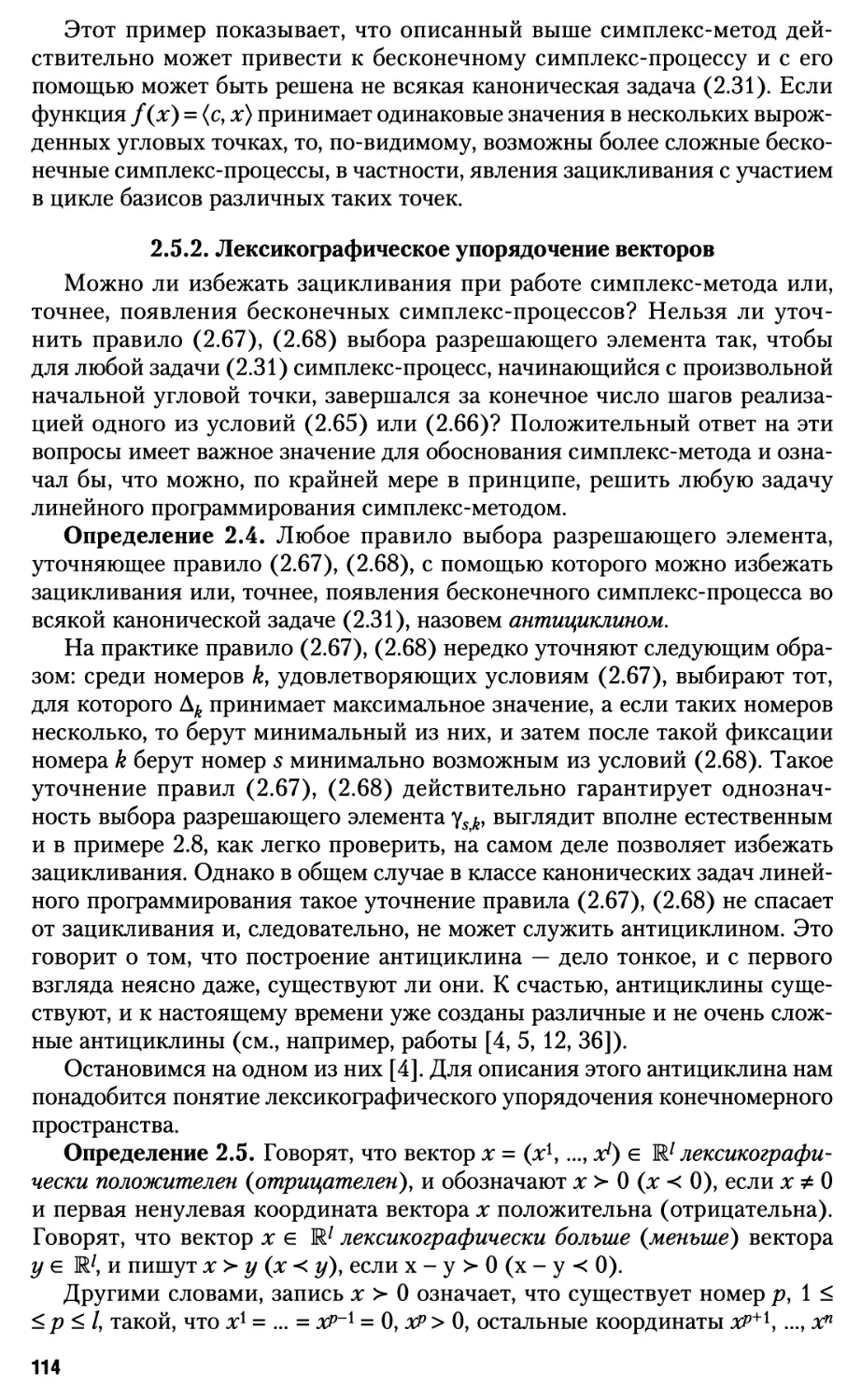

2.5.* Антициклин 112

2.5.1. Пример 112

2.5.2. Лексикографическое упорядочение векторов 114

2.5.3. Лексикографический антициклин 116

2.5.4. Симплекс-метод в канонической задаче максимизации 121

2.6. Поиск начальной угловой точки 122

2.7. Теорема Вейерштрасса в линейном программировании 126

2.8. Теоремы двойственности 127

Упражнения 137

Глава 3. Элементы выпуклого анализа 140

3.1. Выпуклые функции 140

3.1.1. Понятие выпуклой функции 140

3.1.2. Критерии выпуклости 143

3.1.3. Свойства точек минимума выпуклых функций 146

3.1.4. Другие свойства выпуклых функций 148

3.2. Сильно выпуклые функции 151

3.2.1. Понятие сильно выпуклой функции 151

3.2.2. Критерии сильной выпуклости 153

3.3. Метрическая проекция 157

3.4. Теорема Куна — Таккера 164

3.5. Теорема Куна — Таккера для многогранного множества 171

3.6.* Двойственные задачи. Примеры 174

Упражнения 183

Глава 4. Методы минимизации функций 186

4.1. Методы минимизации функций одной переменной 186

4.1.1. Метод деления отрезка пополам 187

4.1.2. Метод золотого сечения 188

4.1.3. Метод ломаных 190

4.1.4. Метод покрытия 194

4.1.5. Метод касательных 198

4.2. Градиентный метод 198

4.2.1. Описание процесса. Выбор шага, проблемы старта и остановки 198

4.2.2. Сходимость метода скорейшего спуска для сильно выпуклых

функций 202

4.2.3. Траектория процесса. Непрерывный аналог градиентного метода 205

4.3. Метод проекции градиента 208

4.3.1. Описание процесса. Варианты выбора шага 208

4.3.2. Сходимость метода для сильно выпуклых функций 209

4

4.4. Метод условного градиента 211

4.4.1. Идея линейной аппроксимации и варианты ее реализации 211

4.4.2. Сходимость метода 214

4.5. Метод Ньютона 216

4.5.1. Описание процесса. Варианты выбора шага 216

4.5.2. Сходимость классического метода Ньютона для сильно

выпуклых функций 217

4.5.3. Сходимость метода Ньютона с переменным шагом для сильно

выпуклых функций 220

4.6.* Метод переменной метрики 223

4.6.1. Описание процесса. G-проекция 223

4.6.2. Сходимость метода переменной метрики для выпуклых функций ....227

4.6.3. Непрерывный вариант метода переменной метрики 230

4.7.* Квазиньютоновские методы 233

4.8. Метод покоординатного спуска 245

4.8.1. Основная версия метода для задач без ограничений 245

4.8.2. Другие варианты метода покоординатного спуска 247

4.9. Метод покрытия для функции многих переменных 249

4.10.* Метод модифицированных функций Лагранжа 252

4.11.* Экстраградиентный метод 259

4.11.1. Описание процесса 259

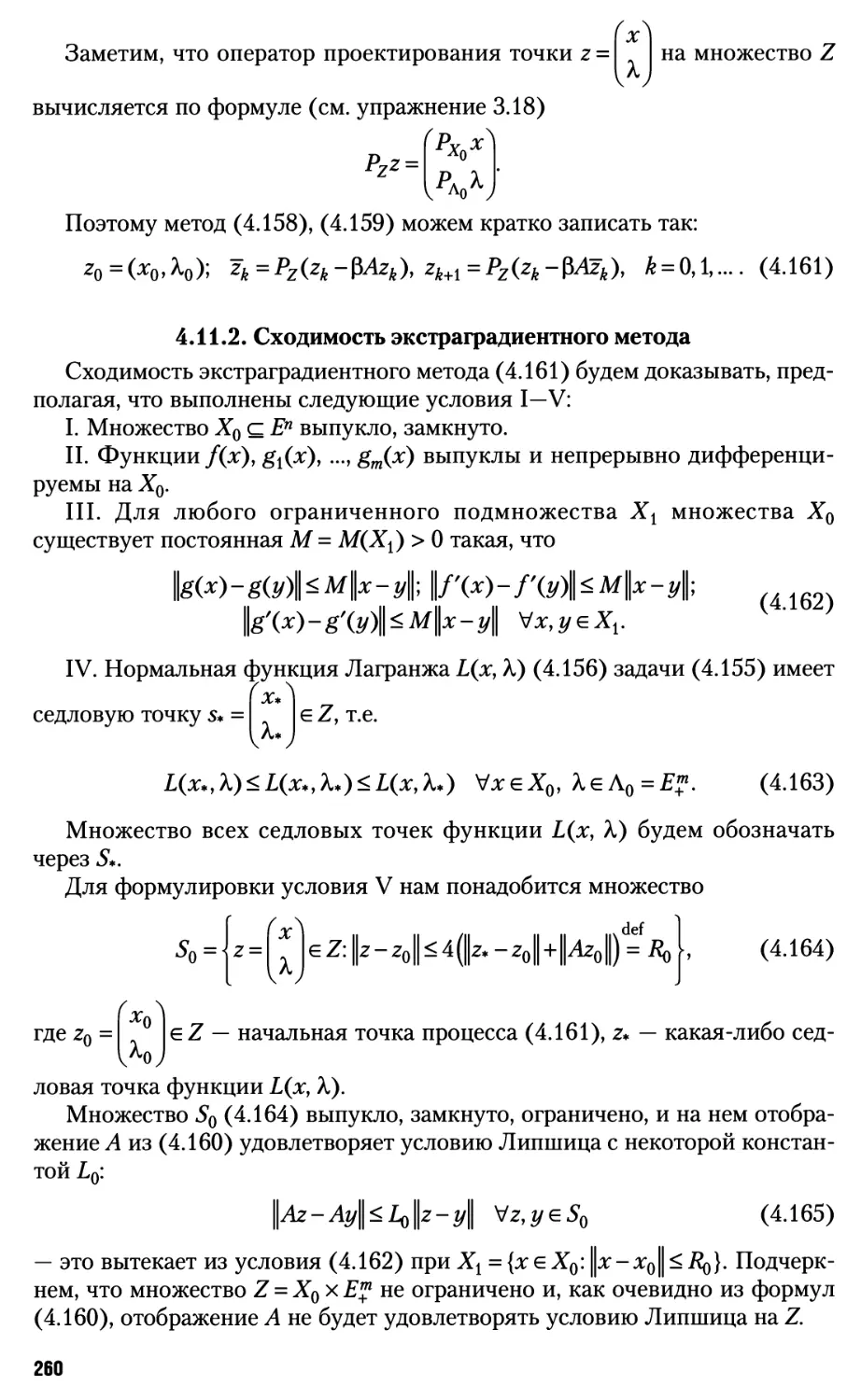

4.11.2. Сходимость экстраградиентного метода 260

Упражнения 264

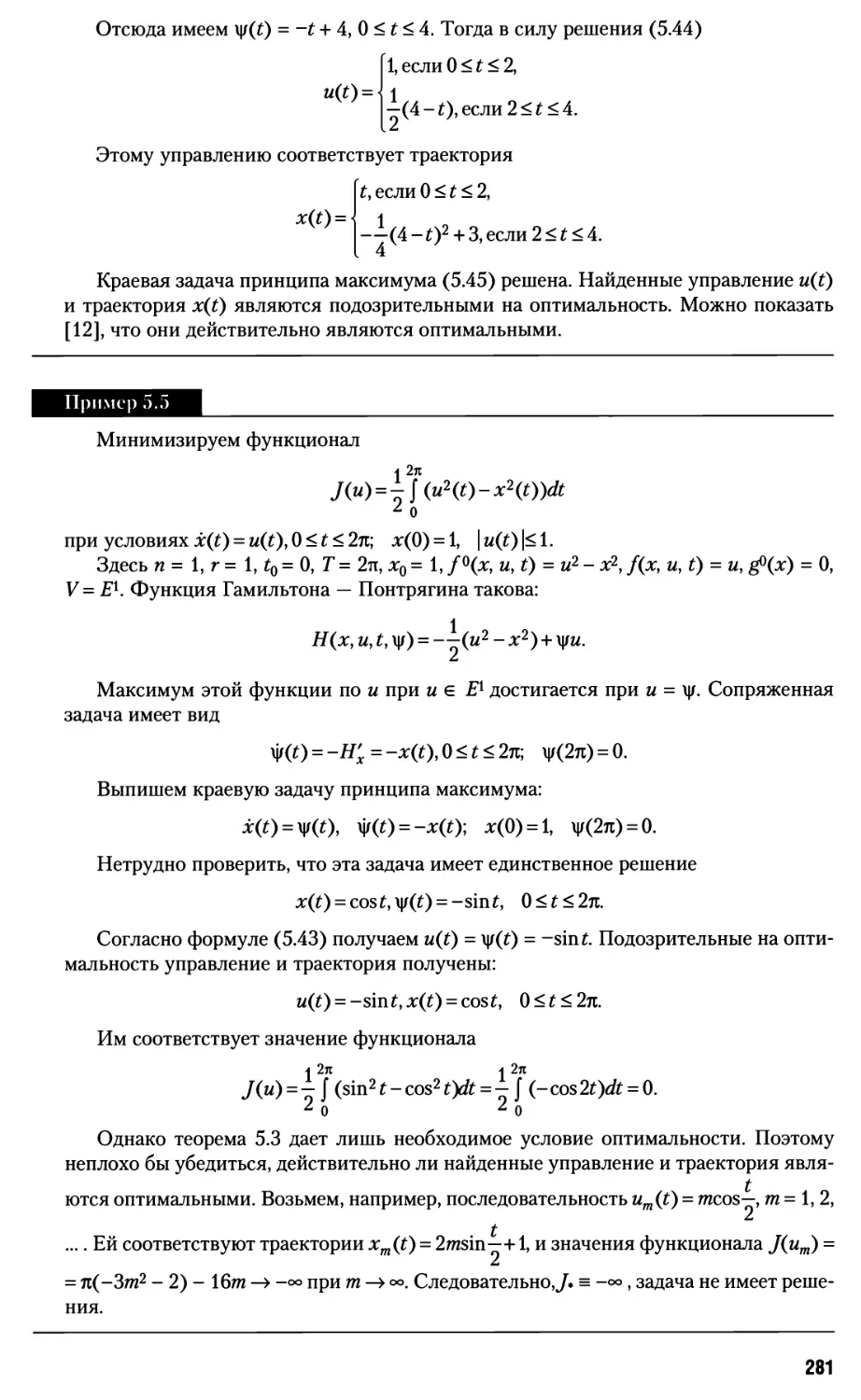

Глава 5. Принцип максимума Понтрягина 266

5.1. Постановка задачи оптимального управления 266

5.1.1. Примеры постановок задач оптимального управления 266

5.1.2. Допустимые управления 269

5.1.3. Задача Коши 270

5.1.4. Постановка задачи 274

5.2. Принцип максимума в задаче оптимального управления

со свободным правым концом 277

5.2.1. Формулировка принципа максимума 277

5.2.2. Краевая задача принципа максимума 278

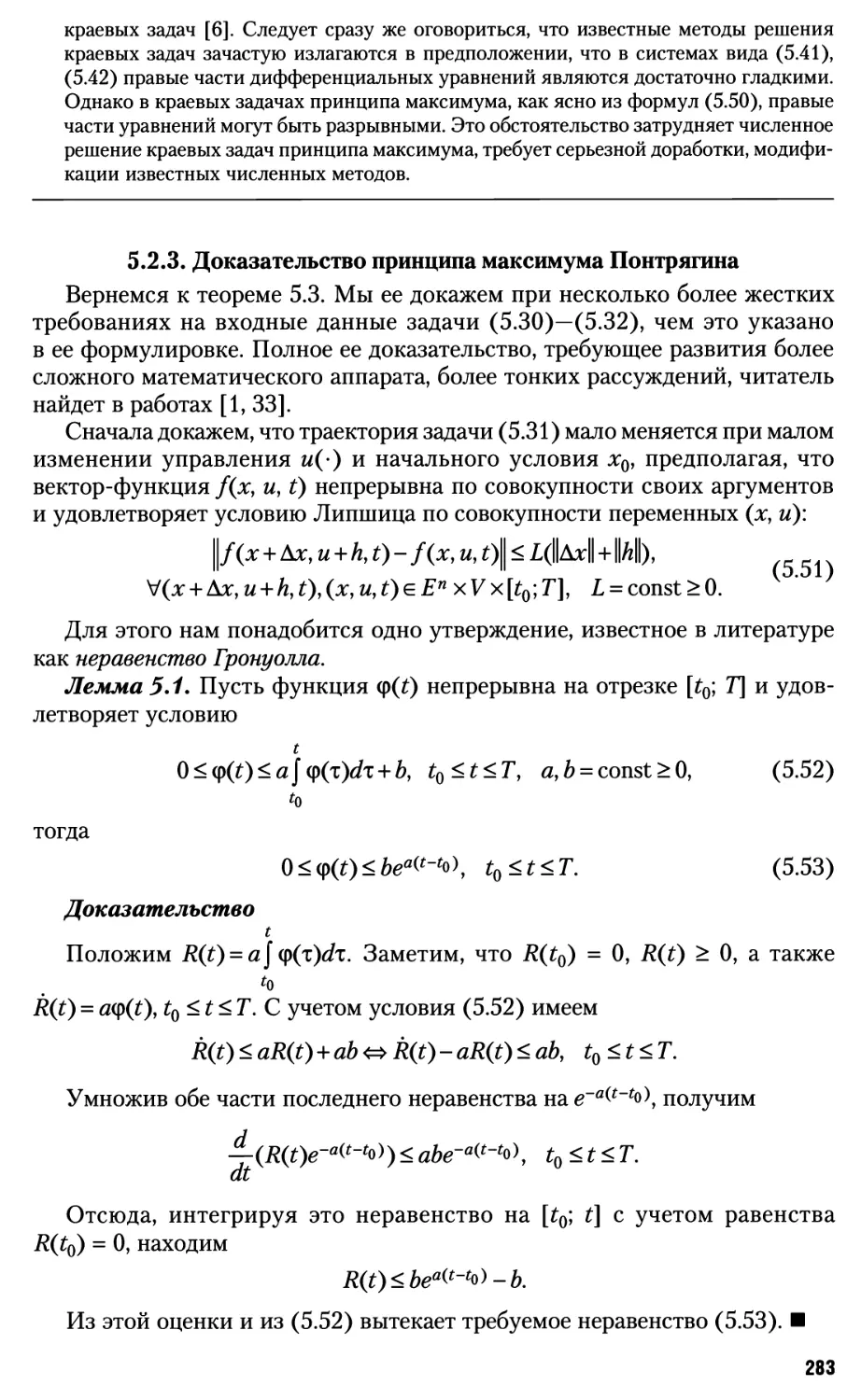

5.2.3. Доказательство принципа максимума Понтрягина 283

5.3.* Принцип максимума (общий случай) 287

5.3.1. Формулировка принципа максимума в общем случае 287

5.3.2. Краевая задача принципа максимума в общем случае 289

5.3.3. Общие граничные условия 291

5.4.* Примеры 293

5.5.* Принцип максимума и классическое вариационное исчисление 305

Упражнения 309

Глава 6. Динамическое программирование 313

6.1. Принцип оптимальности 313

6.2. Схема Беллмана 315

6.2.1. Разностная аппроксимация задачи оптимального управления 315

6.2.2. Уравнение Беллмана 316

5

6.2.3. Вычислительная схема 319

6.2.4. Синтезирующая функция 321

6.2.5. Оценка погрешности 322

6.2.6. Построение минимизирующих последовательностей 324

6.2.7. Приложение к задачам конечномерной оптимизации 325

6.2.8. Замечания к схеме Беллмана 326

6.3.* Проблема синтеза для систем с непрерывным временем 327

6.3.1. Задача Коши — Беллмана 328

6.3.2. Примеры 331

6.3.3. Приближенный метод 334

6.3.4. Оценка погрешности 337

6.4.* Контрпримеры 339

6.5.* Применение метода динамического программирования к задачам

дискретной оптимизации 342

Упражнения 346

Практикум 349

Литература 363

Ответы к упражнениям 366

Предметный указатель 372

Обозначения

R — числовая ось

[a; b] = {xe R : а < х < Ь) — отрезок

(a; b) = {xe R : а < х < Ь) — интервал

(а; Ь] = {х е R : а < х < Ь), [а; Ь) = {х е R : а < х < Ь) — полуинтервалы

Шп — и-мерное линейное пространство векторов-столбцов х с

координатами Я1', 1=1, ..., П

хт =(х1,...,хп) — вектор-строка, полученная транспонированием

вектора-столбца х

j_

Ы|р = £ИР \, 1 <р < °°, IUL = тахЦ — нормы вектора хвМ.п

U=l

\<i<n

En — и-мерное евклидово пространство, представляющее собой про-

п

странство Rn , оснащенное скалярным произведением (х, у) = ^х1у1

\\Х\\ = \\Х\\2=\\Х\\ЕП

— евклидова норма вектора

U=l

{ev ..., еп} — ортонормированный базис пространства Еп, где е{ - (О, ...,

О, 1, 0, ..., 0)т — вектор-столбец, i-я координата которого равна единице,

а остальные равны нулю, г - 1,..., п

Л =

41

\.атп,1

\п

*тпуп J

= {щj, i = \,...,m; j = l,...,n} =

С „ \

\anj

= (Д.-. А,)-

матрица размера тпхпс элементами а^ где а{ = (aiX,..., ain) — i-я строка матрицы

A, Aj = (ay,..., amj)T —j-vi столбец матрицы А

Ат =

а,

14

Kai,n

ыл

а,

( лтЛ

= (aj,...,aj) =

7П,П J

А1

v^y

матрица размера пхтп,

полученная транспонированием матрицы А размера тпхп

I„=(ev...,en) =

^

V п )

— единичная матрица и-го порядка со столбцами

е1> •••» еп

detA — определитель квадратной матрицы А

Л-1 — обратная матрица для квадратной матрицы А с detA Ф О

гапкЛ — ранг матрицы А

n

Ax = ((Ax)1, ..., (Ах)т)т, где (Ax)1 = ^atjXJ, * = 1> •••> m> ~ произведение

7=1

матрицы размера m x n на вектор хе Еп

\\a\\ = max || Ax\\Em — норма (операторная норма) матрицы А размера тхп

ЫЕп ^1

АВ — произведение матрицы А = {аф размера тхп на матрицу В = {by}

размера пх q, его результатом является матрица С = {Су} размера тх q

п

с элементами с$ = X ЩФш^ * = 1> •••> mJ- 1> •••> Ч

k=i

А > О — неотрицательно определенная симметричная матрица, т.е.

(Ах, х)>0 для всех хе Еп

А > О — положительно определенная симметричная матрица, т.е.

(Ах, х)>0 для всех хе Еп,хфО

А < 0 — неположительно определенная матрица, т.е. (~А) > О

А < О — отрицательно определенная матрица, т.е. (~А) > О

х = (х1,..., хР)Т > 0 — неотрицательный вектор, т.е. х1 > О для всех г = 1,..., п

х = (х1,..., хп)т > 0 — положительный вектор, т.е. х1 > О для всех i = 1,..., п

х = (х1,..., хпУ > (у1,..., z/w)T — вектор х не меньше вектора у, т.е. х - у > О

л: = (х1,..., xw)T > (у1,..., уп)т — вектор х больше вектора у, т.е. х - у > О

£^? = {х е Еп\ х > 0} — неотрицательный ортант пространства Еп

х+ =(х\,...,хг1У, где х\ = max{0;.r*}, г = 1, ..., п, — проекция вектора х

на неотрицательный ортант пространства Еп

х = (х1, ..., хп)т > 0 — лексикографически положительный вектор, т.е.

х^Ои первая ненулевая координата этого вектора положительна

х = (х1,..., хп)т > (у1,..., уп)т — вектор х лексикографически больше

вектора у, т.е. х - у > 0

х* =lexmin^ — лексикографический минимум множества векторов {xt,

ieM

г е М), т.е. для каждого номера г е М либо х{ >- х*, либо х{ = х*

S = S(v,B) = \ — симплекс-таблица угловой точки v с базисом В, где

Г = (IY ..., Гг)т, Г, = (уя, Y,.lf..., yin), i = 1,..., г, Д = (А0, Ах,..., Д„)

ГгЛ]

5 =

чА/

>-0 — лексикографически положительная симплекс-таблица, т.е.

Г, > 0 для всех i = 1,..., г

11 - ' *

>-59 =

I До /

— симплекс-таблица Sx лексикографически больше

симплекс-таблицы 52, т.е. А{ > А2

X — замыкание множества X

ТрХ — граничные точки множества X

intX — внутренние точки множества X

dimX — размерность множества X

Хи Y — объединение двух множеств X и Y

X nY— пересечение двух множеств X и Y

X + Y — сумма двух множеств X и Y

8

X \ Y — разность двух множеств X и Y

оХ — произведение числа а на множество X

X х Y — прямое (декартово) произведение двух множеств X и Y

0 — пустое множество

р(х,Х) = inf \х - у\ — расстояние от точки х до множества X

уеХ

0(v, е) = {х е Еп\ \\х - v\\ < е} — 6-окрестность точки v, представляющая

собой открытый шар радиуса 6 > 0 с центром в точке v

S(v, К) = {х е Еп\ \\х - v\\ < R) — замкнутый шар радиуса R с центром

в точке v

L1 — ортогональное дополнение подпространства 1с£й

Px(z) — проекция точки z е Еп на множество X

P§(z) — G-проекция точки z e Епнг множество X

f(x) —> min, x e X, — краткая символическая запись задачи минимизации

функции f(x) на множестве X

/* = inf f(x) — точная нижняя грань функции f(x) на множестве X

хеХ

X* = {х g X: f(x) = /* > -°°} — множество точек минимума функции f(x)

наХ

f(x) —> max, x e X — краткая символическая запись задачи

максимизации функции f(x) на множестве X

/* =sup/(x) — точная верхняя грань функции/(х) на множестве X

хеХ

X* = {х е X: f(x) = /* < +°°} — множество точек максимума функции/(х)

наХ

. = f'xi (x) = fxi (x) — частная производная функции/(х) =/(х1,..., хп)

в точке х по переменной х\ г = 1,..., п

f'(x) = ,..., "1 = grad/(x) — градиент функции f(x) в точке х

у дх1 дхп J

^ . = f£xj (x) = fxixj (x) — частная производная второго порядка

по переменным х\ од функции/(х) =/(х1,..., хп) в точке х, i,j = 1,..., п

f'(x) — вторая производная функции f(x) в точке х, она является ква-

дратнои матрицей п-то порядка с элементами ^ ., i,j = 1,..., п

oxloxJ

df(x) v f(x + te)-f(x) , r/ ч

у = hm ■:L^ — — производная функции j(x) в точке х

ае ^^+о ^

по направлению е, || в || = 1

dx(t)

x(t) = —-^- — первая производная функции x(t) по времени t

at

d2x(t)

x(t) = —To — вторая производная функции x(t) по времени t

at1

lim xk — предел последовательности {xk} = (xv x2,..., xk,...)

k—>oo

lim xk — верхний предел последовательности {xk}

k—>oo

lim xk — нижний предел последовательности {xk}

k—>oo

lim f(x) — предел функции f(x) при х —» a

X—H2

lim f(x) — верхний предел функции f(x) при х —> a

x—>a

lim /(x) — нижний предел функции f(x) при х —» я

/(я + 0) = lim /(x) — предел функции /(х) одной переменной x

*->a+0

при стремлении х к точке а справа

f(a-0)= lim /(x) — предел функции f(x) одной переменной х

*->а-0

при стремлении х к точке а слева

0(t) — величина, определенная в окрестности точки t = О и такая, что

0(0

t < С при всех достаточно малых t, где С — некоторая неотрицательная

постоянная

o(t) — величина, определенная в окрестности точки t = 0 и такая, что

£->0 t

С(Х) — пространство непрерывных на замкнутом ограниченном

множестве X функций/(х) с нормой |/|с = тах|/(х)|

СХ(Х) — пространство непрерывно дифференцируемых на множестве X

функций

С2(Х) — пространство дважды непрерывно дифференцируемых на

множестве X функций

С1{(Х) — пространство непрерывно дифференцируемых на множестве

X функций, градиент f(x) которых удовлетворяет условию Липшица на X

Q(I) — множество функций, удовлетворяющих на множестве X

условию Липшица с константой L

Н = Н(х, г/, t, V, а0) — функция Гамильтона — Понтрягина

/ = l(x, y,t. Г, а) — малый Лагранжиан

£ = £(х, К) — функция Лагранжа в общей форме

L = L(x, X) — функция Лагранжа в нормальной форме

М = М(х, X) — модифицированная функция Лагранжа

V — квантор общности

3 — квантор существования

g — знак принадлежности

с — знак строгого включения одного множества в другое

с — знак нестрогого включения одного множества в другое

def

= — знак определения, используется при введении объектов

Предисловие

Первые задачи геометрического содержания, связанные с отысканием

наименьших и наибольших величин, появились еще в древние времена.

Развитие промышленности в XVII—XVIII вв. привело к необходимости

исследования более сложных задач на экстремум и к появлению

вариационного исчисления. Однако лишь в XX в. при огромном размахе

производства и осознании ограниченности ресурсов Земли во весь рост встала

задача оптимального использования энергии, материалов, рабочего

времени, большую актуальность приобрели вопросы наилучшего в том или

ином смысле управления различными процессами физики, техники,

экономики и др.

Сюда относятся, например, задача организации производства с целью

получения максимальной прибыли при заданных затратах ресурсов, задача

оптимальной организации перевозок при ограниченном количестве

транспортных средств, задача минимизации издержек (отходов) производства,

задача оптимального размещения объектов производства, оптимального

использования посевной площади, оптимального управления запасами,

оптимальной организации работы пунктов массового обслуживания,

выбора оптимальных сроков сезонного производства, задача управления

системой гидростанций и водохранилищ с целью получения

максимального количества электроэнергии, задача о космическом перелете из одной

точки пространства в другую наибыстрейшим образом или с наименьшими

затратами энергии, задача о быстрейшем нагреве или остывании металла

до заданного температурного режима, задача о наилучшем гашении

вибраций и многие другие задачи.

На математическом языке такие задачи, называемые задачами

оптимизации, могут быть сформулированы как задачи отыскания экстремума

(минимума или максимума) некоторой функции (функционала) f(x)

на заданном множестве X из некоторого пространства. Функцию f(x)

принято называть целевой функцией, а ее аргумент х часто называют

параметром управления или допустимой точкой, множество X — допустимым

множеством. Значение целевой функции f(x) выражает собой качество

(цену) допустимой точки х. Требование принадлежности точки х

множеству X выражает собой наличие некоторых ограничений, вытекающих,

например, из законов сохранения энергии, ограниченности имеющихся

ресурсов, возможностей технической реализации управления,

нежелательности каких-либо запрещенных (аварийных) состояний и т.п.

Сразу же заметим, что на практике формулировка задач оптимизации,

составление целевой функции/(х) и множества X являются сложной

проблемой, требующей больших знаний в предметной области, материальных

11

затрат по сбору и анализу информации, постановке необходимых

экспериментов и т.п. Обсуждение возникающих здесь вопросов является

предметом особой области знаний, называемой математическим моделированием,

и выводит нас за рамки настоящего учебного пособия. Чтобы читатель

имел некоторое представление об этой сложной работе по формулировке

задач оптимизации, в гл. 2 будут приведены примеры линейных задач

оптимизации.

В общем случае, говоря о задаче оптимизации, мы будем подразумевать,

что известны целевая функция f(x), допустимое множество X и цель, т.е.

ищется ли минимум или максимум функции. Далее возникает проблема:

как искать экстремум функции f(x) на множестве X? Если множество X

содержит небольшое число точек, то задачу оптимизации можно решить

относительно просто: достаточно вычислить значения целевой функции

в этих точках и, сравнивая их по величине, простым перебором найти

экстремальное (минимальное или максимальное) значение и указать точку,

где этот экстремум достигается. Однако если число точек в X велико

и даже, возможно, бесконечно, то такой метод простого перебора не под

силу современным вычислительным средствам. Как искать экстремум

в такой ситуации? Ясно, что нужны специальные методы оптимизации,

нужна теория таких методов, нужна наука.

Читатель отчасти уже знаком с классическим методом

оптимизации, основанном на дифференциальном исчислении, который излагается

в основных курсах по математическому анализу. В настоящее время

теория оптимизации обогатилась фундаментальными результатами,

полученными по таким направлениям, как линейное программирование, выпуклое

программирование, динамическое программирование, стохастическое

программирование, дискретная оптимизация, теория оптимального

управления процессами, описываемыми дифференциальными уравнениями, и др.

Потребности практики способствовали бурному развитию методов

решения задач оптимизации. Появление современных вычислительных средств,

компьютеров сделало возможным эффективное решение многих важных

прикладных задач оптимизации, которые ранее из-за своей сложности

казались недоступными, появились пакеты программ оптимизации.

В настоящем учебнике излагаются элементы теории оптимизации,

а также основы наиболее часто используемых на практике методов

приближенного решения задач оптимизации и краткая характеристика этих

методов. Усилия авторов были направлены на поиск наиболее экономных

схем изложения, упрощение доказательств, чтобы сделать материал более

доступным, не снижая уровня строгости.

Руководствуясь этими методическими соображениями, авторы вынесли

в первую главу метод штрафных функций, для изложения и понимания

которого, по сути, достаточно знания свойств непрерывных функций

многих переменных из классического математического анализа. Это дало нам

возможность в первой же главе с помощью аппарата штрафных функций

дать простое доказательство важнейшего в теории оптимизации правила

множителей Лагранжа. Во второй главе дается элементарное

изложение основ линейного программирования с привлечением минимального

12

математического аппарата, опираясь лишь на самые первичные понятия

из линейной алгебры, такие как матрица, определитель, линейная

зависимость и независимость векторов, ранг матрицы, произведение матриц,

обратная матрица, не предполагая знания довольно сложной теории

выпуклых многогранных множеств. И в последующих главах авторы

старались уделить методическим аспектам большое внимание, стремясь полнее

и проще излагать основные факты теории и методов оптимизации.

К сожалению, ограниченный объем книги не позволяет уделить

внимание таким важным разделам теории и методов оптимизации, как

дискретная оптимизация, стохастическая оптимизация, вопросам устойчивости

вычислительных алгоритмов, методам решения неустойчивых задач, задач

большой размерности и др.

Материал книги для своего понимания требует лишь знания основ

математического анализа, линейной алгебры, элементов теории

обыкновенных дифференциальных уравнений в объеме стандартных курсов

бакалавриата и магистратуры технических вузов. В книге выделены основной

и дополнительный тексты. Основной текст описывает материал

действующей типовой программы «бакалавр-магистр». Дополнительный текст,

служащий для более углубленного усвоения материала и предназначенный

магистрам, в оглавлении и в заголовках внутри книги помечен символом *.

О содержании книги можно судить по оглавлению. В книге

значительное место занимает иллюстративный материал, примеры задач с разбором

решений. В конце каждой главы приведены вопросы и упражнения

теоретического характера, а в конце учебника отдельным блоком представлен

практикум — задачи для самостоятельной работы студентов.

При составлении заданий практикума к гл. 1,2 мы пользовались

упражнениями из задачника [5], к гл. 5, 6 идеи заданий заимствованы из книги [15].

При работе над книгой авторы опирались на свой опыт работы со

студентами на факультете ВМК МГУ имени М. В. Ломоносова. В книге широко

использованы материалы монографии Ф. П. Васильева [12], касающиеся

конечномерных задач и методов их решения, а также задач оптимального

управления процессами, описываемыми обыкновенными

дифференциальными уравнениями. Эту книгу можно считать продолжением настоящего

учебника.

По рассматриваемой в учебнике проблематике имеется обширная

литература. Список литературы в конце учебника отражает лишь некоторые

источники, которые были непосредственно использованы при написании

книги или близко примыкают к ней, расширяя и дополняя ее содержание.

Авторы выражают глубокую благодарность А. В. Тимохову за

материалы, которые были существенно использованы при составлении

заданий по практикуму к гл. 1—3, а также В. Ю. Королеву за полезные советы

по содержанию книги.

В результате освоения дисциплины у студента должны формироваться

следующие профессиональные компетенции:

знать

• классификацию задач оптимизации (задачи безусловной и условной

оптимизации; классическую задачу на условный экстремум; задачи матема-

13

тического, выпуклого, линейного программирования; задачи оптимального

управления);

• основные положения теории оптимизации (теория необходимых

и достаточных условий оптимальности для конечномерных задач, правило

множителей Лагранжа, теория двойственности задач линейного

программирования, принцип максимума Понтрягина в оптимальном управлении

и др.);

• элементы выпуклого анализа как основы современной теории

оптимизации;

• классификацию численных методов оптимизации (конечношаговые

и бесконечношаговые методы, методы условной и безусловной

оптимизации, методы нулевого, первого и второго порядков);

• понятийный аппарат численных методов оптимизации (итерация

метода, начальная точка, направление убывания, критерий останова,

сходимость метода);

уметь

• аналитически решать простейшие нелинейные задачи оптимизации,

используя теорию необходимых и достаточных условий оптимальности;

• аналитически решать простейшие задачи линейного

программирования, используя симплекс-метод;

• строить прикладные модели, сводящиеся к задачам оптимизации;

• анализировать характеристики прикладной задачи оптимизации

(целевую функцию, допустимое множество) на предмет ее отнесения

к конкретному классу задач;

• выбирать адекватный численный метод решения прикладной задачи

оптимизации (с последующим обращением к соответствующим

библиотекам компьютерных программ);

владеть

• навыками решения задач оптимизации;

• материалом дисциплины на уровне, позволяющем формулировать,

исследовать и решать прикладные задачи оптимизации.

Авторы будут признательны читателям за советы и критические

замечания по содержанию книги.

Глава 1

ВВЕДЕНИЕ В ОПТИМИЗАЦИЮ.

КЛАССИЧЕСКИЙ МЕТОД

1.1. Постановка задачи

1.1.1. Задача минимизации

Перед тем как начать изложение теории оптимизации, введем

некоторые обозначения и напомним определения из линейной алгебры и

математического анализа [9, 22, 29, 31]. Через Шп будем обозначать и-мерное

вещественное линейное пространство, состоящее из вектор-столбцов

ytl

\л )

. У =

, z =

с действительными координатами я1', у\ z\ г - 1,..., п\ сумма х + у двух

вектор-столбцов и произведение со: вектор-столбца х на действительное число

авМй определяются обычным образом:

гх1 + у1'

, ах =

Вектор-столбец

о= ...

W

называется нулевым. Вектор-строку, полученную транспонированием

вектор-столбца х, обозначим через хт = (х{,...,хп). Там, где не могут

возникнуть недоразумения, вектор-столбец из Шп или соответствующую ему

вектор-строку для краткости мы часто будем называть просто вектором или

точкой, а знак транспонирования «т» будем опускать.

п

Если в Rn ввести скалярное произведение двух векторов (х,у) = ^х1у\

*=1

х,уеЖп, то Шп превращается в и-мерное евклидово пространство, которое

будем обозначать через Еп. Если {х, г/) = 0, то векторы х и у называются

ортогональными. Это скалярное произведение порождает норму (длину)

вектора в Еп, которую вычисляют по формуле

15

Ы|= (x,x)V2 =

Величину

р(х,у) = \\х-у\\ =

V>1

,2^

называют евклидовым расстоянием между точками х, у е Еп.

Для любых трех точек x,y,ze En справедливо неравенство

||;c-y||<||jc-z|| + ||z-y||,

называемое неравенством треугольника. Когда важно подчеркнуть, что

скалярное произведение, норма, расстояние взяты именно в Еп, мы будем

писать (х,у)ЕП, ||х||£Я,||х-у||£11.

В Еп справедливо неравенство Коти — Буняковского

(х, у) < \\х\\ • || у Цдля \/х,уе Еп,

причем неравенство превращается в равенство тогда и только тогда, когда

векторы х, у коллинеарны, т.е. х = ау при некотором а.

Иногда мы будем пользоваться и другими нормами векторов из Mw,

такими как

(п И1/р

\г=1 )

\<i<nx

Как известно, в конечномерных пространствах все нормы

эквивалентны. Это значит, что если ||-||7, \\п — две нормы в Rn, то существуют

такие положительные числа тх и т2, что /wjlx ||7 < ||х\п < т2||#||/для любого

х е Rn. Отсюда следует, что если последовательность {xk} сходится к точке

х в какой-либо норме ||-||/, т.е. \\xk - x\\j —> 0 при k —> °о, то эта

последовательность будет сходиться кхив любой другой норме ||||/7, в частности

\%ь ~*11 = max m -х{\ —> 0, что равносильно покоординатной сходимости.

11 ||о° 1<1<я' * '

В основном мы будем работать в евклидовом пространстве Еп. Перейдем

к постановке задач оптимизации.

Пусть X — некоторое известное множество из и-мерного евклидова

пространства En, a f(x) = /(х1,..., хп) — функция, определенная на этом

множестве. Кратко задачу оптимизации будем записывать следующим образом:

/(х)—>min, xeX. (1.1)

Поясним, что подразумевается под задачей (1.1). Начнем с того, что

напомним некоторые определения из классического математического

анализа [22, 29].

Определение 1.1. Точку х* е X будем называть точкой минимума функции

f(x) на множестве X, если f(x*) < f(x) для всех хе X; величину f(x*) назовем

наименьшим значением/(г) на X и обозначим minf(x) = /* = f(x*). Множе-

хеХ

ство всех точек минимума функции/(г) на X будем обозначать через X*.

16

В зависимости от свойств множества X и функции f(x) множество X*

может содержать одну, несколько и даже бесконечно много точек, а также

возможны случаи, когда множество X* пусто. Поясним это на примерах.

Пусть

21Ы1

/(*) = _£Е!!_ х = (х\...,хп)еЕп.

1+1Ы1

График этой функции при п = 1 изображен на рис. 1.1.

На множестве Хх = Еп минимальное значение этой функции равно нулю:

/*=/(0) = 0, множество X* точек минимума состоит из единственной точки х*=0.

На множестве Х2 = {х е Еп: \\х\\ > 1} функция f(x) не имеет минимального значения,

так как/(х) > 0 при всех х е Х2, причем на последовательности xk, k= 1,2,...,

функция стремится к нулю: lim/(x^) = 0, но равенство/(х) = 0 невозможно ни в одной

точке х е Х2, так что Х2* = 0.

Пример 1.2

Пусть

[ 1

г, ч и-м,еслих*О,

[1,еслих = 0;

График этой функции при п = 1 изображен на рис. 1.2.

У\

Рис. 12

На множествах Хх = Еп или Х2 ={х е Еп :\\х\\> 1} функция/(х) принимает строго

положительные значения, множество точек ее минимума пусто.

17

Если X = Х3 ={х еЕ»:\\х\\< 1/2}, то/.=1, Х3* = {х = 0}.

ЕслиХ = Х4={хе Еп : ||х||<2}, то/ =-, Х4* = {ig Х4 : ||х|| = 2} — я-мерная сфера

с центром в точке х = 0 (при п = 1 Х4* — это две точки х* = 2 и х* = -2).

Если Х = Х5= {хе & : ||х|| < 1}, то/* = 1, Х5*= {хе Х5: ||х|| = 1} и {х = 0}.

Пример 1.3

Пусть

// ч Jsin2 ~

/(х)= \х j

[О прих = 0.

График этой функции изображен на рис. 1.3.

при х > 0,

3 2

Рис. 13

На множестве X = Xt = {х: 1 < х < 2} /* = 0, Xt* = {x* =1}.

f 1 | 11

Если X = Х2 = \ х: — < х < 1 к то/* = 0, Х2* состоит из трех точек xt = —, х2 = —, х3 = 1.

ЕслиХ = Х3 = {х:0< 1}, то/* = 0,Х3*= xgX3:x = -,wgn|u{x = 0}.

Пример 1.4

Пусть /(х) = In х, X = {х е Я1: 0 < х < 1}.

Здесь

(рис. 1.4).

Здесь X* = 0, для последовательности х^ =—, k = 1, 2, ..., имеем lim/(x^) = -

Pwc. 14

18

Определение 1.2. Функция/(х) называется ограниченной снизу на

множестве X, если существует такое число М0, что f(x) > М0 для всех х е X.

Функция f(x) не ограничена снизу на X, если существует

последовательность {xk} е X, для которой lim f(x) = -°°.

£->оо

В примерах 1.1—1.3 функции ограничены снизу на рассматриваемых

множествах. В примере функция не ограничена снизу, хотя и принимает

конечные значения во всех точках из X

В тех случаях, когда X* = 0, естественным обобщением понятия

наименьшего значения функции на множестве является понятие точной

нижней грани функции.

Определение 1.3. Пусть функция/(х) ограничена снизу на

множестве X. Тогда число /* называют точной нижней гранью или инфимумом

f(x) на X, если

1) /* < f(x) при всех х е X;

2) для любого сколь угодно малого числа 6 > 0 найдется точка х£е X

такая, что f(x£) < /* + 6.

Точную нижнюю грань f(x) на X будем обозначать через inf f(x) = /*.

хеХ

Если функция f(x) не ограничена снизу на X, то в качестве точной нижней

грани f(x) на X принимается /* = -°°.

В примерах 1.1 и 1.2/* = 0, а множество X* может быть пустым или

непустым в зависимости от множества X; в примере 1.4 f* = -°о, X* = 0.

Если X* Ф 0, то, очевидно, точная нижняя грань Дт) на X совпадает с

наименьшим значением этой функции на X, т.е. inf f(x) = minf(x). В этом слу-

хеХ хеХ

чае говорят, что функция f(x) достигает своей точной нижней грани в

каждой из точек х* е X*. Подчеркнем, что inf f(x) = f* всегда существует [22,29],

хеХ

причем если f(x) ограничена снизу на X числом М0, то f* > М0 > -«>, и /* = -«>,

еслиДг) не ограничена снизу X Заметим, что если функция достигает

некоторой своей нижней грани, то эта нижняя грань необходимо будет и точной

нижней гранью функции, поэтому в дальнейшем в тексте мы в некоторых

случаях для краткости будем говорить «функция достигает своей нижней

грани».

После введенных определений можем уточнить постановку задачи (1.1).

Здесь обычно различают задачи двух типов. К первому типу относят задачи,

в которых требуется определить величину /* = inf f(x) — точную нижнюю

хеХ

грань функции/(х) на множестве X. В таких задачах возможно, что X* = 0.

В задачах второго типа ищется не только величина /«, но и какая-либо

точках* е X*, в которой достигается точная нижняя грань, — здесь уже

подразумевается, что X* Ф 0. Если множество X* состоит более чем из одной

точки, то здесь возможны уточнения постановки задачи (1.1). Например,

нужно искать точку х* е X*, которая ближе всего расположена к заданной

точке х0.

Возможна и более широкая постановка задачи минимизации второго

типа, когда ищутся не только точки минимума в смысле определения 1.1,

но и точки так называемого локального минимума.

19

Определение 1.4. Точках* е X называется точкой локального минимума

функции/(х) на множестве Xсо значением/*=f(x*), если существует такая

малая 6-окрестность 0(х*, г) = {хе Еп : \\х -х*\\ < е} точки х», что fix*) <f(x)

для всех х е X п 0(х*, б). Если при некотором 6 > 0 равенство f(x*) = f(x)

для х е X п 0(х*, б) возможно только при х = х*, то х* называют точкой

строгого локального минимума.

Для функции, график которой изображен на рис. 1.5, точки х0, х2, х4

являются точками строгого локального минимума, а в точках х,

удовлетворяющих неравенствам х5 < х < х6 и х8 < х < х9, реализуется нестрогий

локальный минимум. Других точек локального минимума у данной

функции нет.

a — xQ хх х2 х3 х4 х5 х6 х7 х8 х9 о — х10 х

Рис. 15

Точки локального минимума, в которых минимум достигается в смысле

определения 1.1, в литературе часто называют точками глобального

минимума или точками абсолютного минимума функции f(x) на множестве X.

Для функции, изображенной на рис. 1.5, X* = {х2} и [х8; х9] — точки

глобального минимума.

1.1.2. Задача максимизации

Перейдем к обсуждению постановки задачи максимизации, которую

кратко будем записывать так:

f(x) —> max, x e X. (1.2)

Для пояснения постановки задачи (1.2), как и в случае задачи

минимизации (1.1), нам понадобятся некоторые определения.

Определение 1.5. Точку х* е X будем называть точкой максимума

функции f(x) на множестве X, если f(x*) > f(x) для всех х е X; величину

f(x*) назовем наибольшим или максимальным значением f(x) на X и

обозначим тах/(х) = /(х*) = /*. Множество всех точек максимума/(х) на X

хеХ

будем обозначать через X*.

Определение 1.6. Функция f(x) называется ограниченной сверху

на множестве X, если существует такое число Mv что f(x) < Мх для всех

х g X. Функция f(x) не ограничена сверху на X, если найдется

последовательность {xk} g Xтакая, что lim fixk) = +°°. Если функция ограничена на X

k—>oo

и сверху, и снизу, то она называется ограниченной на X.

20

Определение 1.7. Пусть функция/(г) ограничена сверху на

множестве X. Тогда число /* называется точной верхней гранью или супремумом

f(x) на X, если:

1) /* >f(x) при всех хе X;

2) для любого сколь угодно малого числа 6 > 0 найдется точка хе е X

такая, что f(xE) > /* - е.

Точную верхнюю грань/(х) на X будем обозначать через sup/(x) = /*.

хеХ

Если функция f(x) не ограничена сверху на X, то в качестве точной

верхней грани f(x) на X принимается /* = +°°.

Если X* Ф 0, то, очевидно, точная верхняя грань f(x) на X совпадает

с максимальным значением этой функции на X, т.е. sup/(.r) = max/(.r).

хеХ хеХ

В этом случае говорят, что функция/(г) на X достигает своей точной

верхней грани в точке х* е X*. Подчеркнем, что sup/(x) = /* всегда существует

хеХ

[22, 29], причем еслиДг) ограничена сверху на Xчислом Мь то/* <МХ<

< +°°, и/* = +°°, если/(х) не ограничена сверху на X. Выражение тах/(х)

хеХ

не всегда имеет смысл. Справедливы соображения, аналогичные

высказанным ранее: если функция достигает какой-то своей верхней грани, то эта

верхняя грань необходимо будет точной верхней гранью.

Для иллюстрации сказанного обратимся к функциям f(x) и

множествам X из примеров 1.1—1.4, но задачи минимизации в них заменим

задачами максимизации.

В примере 1.1 для обоих множеств Хх = Еп, Х2 = {\\х\\ > 1} максимальное

значение функции f(x) равно /* = 1, X* = {Цх|| = 1} — n-мерная сфера

радиуса 1 с центром х = О (при п = 1 это две точки х* = 1 и х* = -1), что следует

из неравенства

21Ы1 (Ы-1)2

1+Ы12" 1+Ы12

l-f(x) = l—^j=KU*\ Z ^0 VxeE",

которое при |д:| = 1 обращается в равенство/(х) = 1 =/*.

В примере 1.2 на множестве X = Х2 = {\\х\\ > 1} максимальное

значение равно/*=1, множество X* = {\\х\\ = 1}; для остальных множеств/* = +°°,

Х*=0.

Г 2

В примере 1.3 на множестве X = [0; +°°) имеем /* = 1, X* =\ х = —-—,

I 2« + 1

6 = 0,1,...}.

В примере 1.4 /* = 0, X* = {х = 1}.

В задачах максимизации (1.2) также можно различать задачи двух

типов: в задаче первого типа ищется величина/*, а в задачах второго типа

ищутся/* и какая-либо точка максимумах* такая, чтоДг*) =/*.

Задачи (1.1), (1.2) тесно связаны между собой равенством

sup/(*) = -inf (-/(*)), (1.3)

хеХ xsX

21

из которого следует, что всякая задача максимизации функции f(x) на X

равносильна задаче минимизации

def

g(.r)->min, хеХ, g(x)=-f(x). (1.4)

Отсюда ясно, что методы, разработанные для решения задач

минимизации, нетрудно переформулировать и использовать для решения задач

максимизации. Поэтому в дальнейшем мы в основном будем исследовать

задачу минимизации (1.1).

Сказанное относится и к задачам поиска точек локального максимума

функции f(x) на множестве X.

Определение 1.8. х*е X называется точкой локального максимума

функции f(x) на множестве X со значением /* = f(x*), если существует такая

малая 6-окрестность 0(х*, г)={х е Еп :\\х- х*\ < е} точки х*, что/(х*) >f(x)

для всех х е X п 0(х*, г). Если при некотором 6 > 0 равенство/(х) =f(x*)

для х е X п 0(х*, е) возможно только при х = х*, то х* называют точкой

строгого локального максимума.

Точки локального максимума, в которых максимум достигается

в смысле определения 1.5, часто называют точками глобального максимума

или точками абсолютного максимума функции f(x) на множестве X.

Для функции, график которой изображен на рис. 1.5, точки xv x3, х7,

х10 являются точками строгого локального максимума, а в точках х,

удовлетворяющих неравенствам х5 < х < х6 и х8 < х < х9, реализуется нестрогий

локальный максимум; х3, х7 — точки глобального максимума. Других точек

локального максимума у нее нет. Обращаем внимание читателя на то, что

все точки х из интервалов (х5, х6) и (х8, х9) одновременно являются как

точками локального минимума, так и точками локального максимума.

Множество всех точек локального минимума или максимума функции

на множестве X принято называть точками локального экстремума

функции на этом множестве или, проще, точками экстремума. Если мы хотим

найти все точки экстремума (как минимума, так и максимума), то,

объединяя постановки задач (1.1), (1.2), кратко будем писать

f(x) —> extr, x g X.

Функцию/(х) в задачах (1.1), (1.2) часто называют целевой функцией,

множество X — допустимым множеством, точки х е X — допустимыми

точками.

1.2. Теоремы Вейерштрасса

1.2.1. Классическая теорема

Как мы видели в простейших примерах 1.1—1.4, функция/(х) может

быть ограниченной или неограниченной сверху или снизу на множестве X,

множество точек ее экстремума может быть пустым или непустым.

Приведем теорему Вейерштрасса из классического математического анализа,

в которой даются достаточные условия на целевую функцию f(x) и

допустимое множество X, гарантирующие конечность точной нижней и точной

верхней граней и непустоту множества точек экстремума f(x) на X. Сна-

22

чала напомним некоторые определения и факты из математического

анализа [20, 22, 29].

Определение 1.9 Пусть {xk} = (xv x2, ..., xk, ...) — некоторая

последовательность точек из Еп. Последовательность {xk} называется

ограниченной, если существует такое число М > 0, что \\xk\\ < М для всех А = 1, 2, ... .

Последовательность {xk} называется неограниченной, если существует ее

подпоследовательность {xk } такая, что limlbty | = +°°- Точка v называется

' /->ооН 'II

предельной точкой последовательности {xk}, если существует ее

подпоследовательность {xk }, сходящаяся к v.

Согласно теореме Больцано — Вейерштрасса [20, 22, 29] всякая

ограниченная последовательность {xk} e Еп имеет хотя бы одну предельную точку.

Определение 1.10. Множество X с Еп называется ограниченным, если

существует число М > 0 такое, что || х || < М для всех х е X. Множество X

называется неограниченным, если существует последовательность {xk} e X

такая, что lim \хЛ = -н».

Определение 1.11. Точка v e Еп называется предельной точкой

множества X, если любая ее е-окрестность 0(v, е) = {х е Еп : || х - v || < е} содержит

точку w е X, отличную от v (w Ф v).

Из этого определения следует, что точка v будет предельной точкой

множества X тогда и только тогда, когда существует последовательность

{xk} е X, хкФ v, k = 1, 2,..., сходящаяся к точке v. Предельная точка

множества X может как принадлежать X, так и не принадлежать ему.

Определение 1.12. Точка v называется внутренней точкой множествах,

если существует ее е-окрестность 0(р, б) = {х е Еп : \\х - v\\ < г}, которая

целиком принадлежит множеству X. Если найдется е-окрестность точки v,

которая не содержит ни одной точки из X, то v назовем внешней точкой

множества X. Если любая е-окрестность точки v содержит как точки из X,

так и точки, не принадлежащие X, то v называется граничной точкой

множества X. Наконец, возможно, что точка v принадлежит множеству X,

но существует е-окрестность этой точки, не содержащая никакой другой

точки этого множества. Такая точка v называется изолированной точкой

множества X.

Совокупность всех внутренних точек множества X будем обозначать

через intX, совокупность всех граничных точек — через ГрХ

Уточним, что изолированная точка v множества X является его

граничной точкой, причем она является предельной точкой единственной

последовательности элементов множества X, а именно {xk= v), k = 1, 2,... .

Внутренние точки множества и его граничные точки, не являющиеся

изолированными, будут предельными точками множества X, а внешние и

изолированные точки множества X не являются его предельными точками.

Определение 1.13. Множество Хс£я называется замкнутым, если оно

содержит все свои предельные точки.

Из вышесказанного вытекает, что замкнутое множество является

объединением всех своих внутренних и граничных (включая изолированные)

точек. В частности, множество, состоящее только из изолированных точек,

является замкнутым.

23

Определение 1.14. Множество ХсР такое, что каждая

последовательность {xk} e X обладает хотя бы одной предельной в смысле

определения 1.11 точкой, лежащей в X, называется компактным.

Из теоремы Больцано — Вейерштрасса и определений 1.9—1.12 следует,

что в Еп компактными являются все замкнутые ограниченные множества

и только они (т.е любое компактное множество из Еп ограничено и

содержит все свои предельные точки).

Примерами компактных множеств в пространстве Еп являются

следующие:

• п-мерный шар радиуса R с центром в точке х0 е Еп

• n-мерная сфера Х= {хе Еп : ||х - х0\\ = R};

• и-мерный параллелепипед X = {х е Еп : а{< х{< biy г = 1, ..., п), где ai9

Ъ{, а{ < Ъ{, г = 1,..., п — заданные числа;

• отрезок X = [и, v] = {х е Еп : х = ха = аи + (1 - сс)а, 0 < ос < 1},

соединяющий точки и, v g Еп\

• множество X = {х е Еп : ||#||(||#|| - 1)(||^|| - 2) < 0}, являющееся

объединением кольца 1 < || х || < 2 и изолированной точки 0.

Примерами некомпактных множеств являются следующие замкнутые,

но неограниченные множества:

• все пространство X = Еп\

def

• неотрицательный ортант X-Е1^ = {х е Еп\ х1 > 0,..., хп > 0};

• гиперплоскость X = {х е Еп : (с, х) = у}, где у — заданное число, с е Еп,

сфО — заданный вектор, который называют нормальным вектором

гиперплоскости;

• полупространство X = {х е Еп : (с, х) < у} или X = {х е Еп : (с, х) > у};

• прямая X = {х g Еп : х = x(t) =x0+td,-°o<t< +°°}, проходящая через

точку х0, с направляющим вектором d e En, d*0;

• лучX = {хе Еп:х = x(t) = x0+td,t> 0}.

Открытый луч X = {х g En:x = x(t) =x0+td,t>0}H открытый n-мерный

шар X = {х е Еп: || х - х0 \\ < R} также являются некомпактными множествами.

Определение 1.15. Пусть функция/(х) определена на множестве X с Еп.

Говорят, что функция f(x) непрерывна в точке х е X, если для любой

последовательности {xk} e X, сходящейся к точке х, справедливо равенство

\imf(xk) = f(x). Функцию/(х) называют непрерывной на множестве X,

k—>oo

если она непрерывна в каждой точке этого множества.

Приведем формулировку теоремы Вейерштрасса для непрерывных

функций в том виде, как она дается в обычных курсах математического

анализа [20, 22, 29].

Теорема 1.1. Пусть X — компактное множество из Еп, функция f(x)

определена и непрерывна на X. Тогда

/* = inf/(x)>-oo, X*={xeX:f(x) = f*}*0;

хеХ

Г = supf(x)<-ко, Г={хеX:f(x) = f*}*0.

хеХ

24

1.2.2. Обобщенная теорема Вейерштрасса

Теорема 1.1 дает достаточные условия разрешимости одновременно как

задачи минимизации (1.1), так и задачи максимизации (1.2).

Между тем на простейших примерах 1.1—1.4 мы видели, что эти задачи

не всегда разрешимы одновременно. Это обстоятельство наводит на мысль

о том, что условия теоремы 1.1, гарантирующие одновременную

разрешимость задач (1.1), (1.2), по-видимому, являются слишком жесткими.

Внимательный анализ теоремы 1.1 показывает, что условие непрерывности

целевой функции/(х) можно существенно ослабить. Оказывается, для

разрешимости задачи минимизации достаточно полунепрерывности снизу

функции /(г), для задачи максимизации — ее полунепрерывности сверху.

Дадим строгое определение этих понятий. Предварительно введем понятие

нижнего и верхнего пределов последовательности.

Определение 1.16. Число а называется нижним {верхним) пределом

ограниченной снизу (сверху) числовой последовательности {ak}, если:

1) существует хотя бы одна подпоследовательность {ak }, сходящаяся

к а;

2) все предельные точки последовательности {ak} не меньше (не больше)

числа а, т.е. число а является наименьшей (наибольшей) предельной

точкой последовательности {ak}.

Нижний и верхний пределы будем обозначать lim ak и lim ak соответ-

ственно.

Иначе говоря, а — нижний (верхний) предел последовательности {ak},

если для любого 6 > 0:

1) существует номер N такой, что ak > а - е (ak < а + е) для всех k > N;

2) для любого номера т найдется номер km> m такой, что ak <a + e

(%^-е).

В том случае, когда {ak} не ограничена снизу (сверху), то по

определению принимают lim ak=-°o (lim ak = -н»); в частности, если lim ak = -©о, то

lim ak = -оо; (если lim ak = +°°, то lim ak = +°°).

Например:

• если ak= (-1)*, k = 1, 2,..., то Итя^ =-1, \imak =1;

• если ak= (-l)kk, k= 1,2,..., то lim ak = -oo, Hm ak = +oo;

• если ak= [1 + (-l)k]k, k = 1, 2,..., то hmak =0, \imak = +oo;

• если ak= hrx, k= 1,2,..., то lim ak = lim ak = 0.

Важно заметить, что нижний и верхний пределы (конечные или

бесконечные), в отличие от обычного предела, у любой последовательности

всегда существуют. Для того чтобы последовательность {ak} имела обычный

предел, необходимо и достаточно, чтобы lim ak = lim ak=a; тогда lim ak = a.

£—>oo k—>°o k—>°o

Определение 1.17. Пусть функция/(х) определена на множестве X с Еп.

Говорят, что функция f(x) полунепрерывна снизу {сверху) в точке х е X,

25

если для любой последовательности {xk} e X, сходящейся к точке х, имеет

место соотношение lim f(xk)> f(x) (lim f(xk)< f(x)). Функцию/(х) назы-

вают полунепрерывной снизу (сверху) на множестве X, если она

полунепрерывна снизу (сверху) в каждой точке этого множества.

На рис. 1.6 изображены графики функций, не непрерывных, но

полунепрерывных снизу в точке а, на рис. 1.7 — не непрерывных, но

полунепрерывных сверху в точке а. Функция, график которой изображен на рис. 1.8,

не является в точке а ни полунепрерывной снизу, ни полунепрерывной

сверху.

»t

Рис. 1.6

У\

Рис. 1.7

Рис. 1.8

Предлагаем читателю доказать, что функция f(x) полунепрерывна

снизу (сверху) в точке х е X тогда и только тогда, когда для любого 6 > О

существует 8 > 0 такое, что для всех у е X таких, что ||у - х\\ < 8,

справедливо неравенство f(y) > f(x) - г if (у) < f(x) + б). Нетрудно убедиться, что

функция непрерывна в точке х тогда и только тогда, когда она в этой точке

полунепрерывна и снизу, и сверху.

26

Пусть Х= {х g Еп : ||х|| < 1} — «-мерный единичный шар;/(х) = ||х|| при 0 < ||х|| < 1

и/(0) = а. Тогда при а < О функция/(х) будет полунепрерывна снизу на X, при а > О —

полунепрерывна сверху на X; при а = О — непрерывна на X

Пример 1.6

Пусть X = (-©о; +°о),

/(*) =

sin—, х>0,

-х, х<0,

1<2, Х = 0.

Тогда при а<-\ эта функция будет полунепрерывной снизу на X, при я > 1 —

полунепрерывной сверху, при | а \ < 1 в точке х = О эта функция не будет

полунепрерывной ни снизу, ни сверху.

Установим связь между свойством полунепрерывности снизу функции

и замкнутостью множеств

М(с) = {хе X: f(x) <c},c = const,

называемых множествами Лебега функции f(x) на множестве X.

Лемма 1.1. Пусть X — замкнутое множество из Еп. Тогда для того чтобы

функция f(x) была полунепрерывна снизу на X, необходимо и достаточно,

чтобы множество Лебега М(с) было замкнутым при всех с (пустое

множество считается замкнутым по определению). В частности, еслиДг)

полунепрерывна снизу на X, то множество X* точек минимума/(х) на X замкнуто.

Доказательство

Необходимость. Пусть f(x) полунепрерывна снизу на X. Возьмем

произвольное число с, будем полагать, что М(с) Ф 0. Рассмотрим какую-либо

предельную точку w множества М(с). Тогда существует последовательность

{xk} g M(c), сходящаяся к w. В силу замкнутости X точка we Х.Из того, что

f(xk) < с, k = 1, 2,..., с учетом полунепрерывности снизу/(х) в точке w имеем

f(w) < lim f(xk) < с, т.е. w e M(c). Замкнутость М(с) доказана. В частности,

k—>оо

множество X* = {х е X:f(x) < f* = inf f(x)} замкнуто.

Достаточность. Пусть для некоторой функции f(x) множество М(с)

замкнуто при любом с. Возьмем произвольные 6 > 0, х е X и

последовательность {xk} е X, сходящуюся к точкех. Пусть lim f(xk)-a- lim f(xk ).

£->оо /И->оо т

Тогда f(xk ) < а + 6, т.е. xk е М(а + б) для всех достаточно больших

номеров km. Но множество М(а + б) замкнуто по условию, а точка х является

пределом для {xk }. Следовательно, х е М(а + б), т.е. f(x) < а + 6. В силу

произвольности 6 > 0 отсюда имеем f(x)<a= lim f(xk). ■

k—>oo

Ниже мы приведем несколько расширенную формулировку теоремы

Вейерштрасса для полунепрерывных функций, используя понятия

минимизирующей или максимизирующей последовательностей. Дело в том, что

27

на практике точно определить координаты точки экстремума удается лишь

в редких случаях, если даже их существование гарантировано строгими

утверждениями типа теоремы 1.1. Ниже мы увидим, что все

итерационные методы оптимизации, по сути, представляют из себя описание правил

построения минимизирующей и максимизирующей последовательностей.

Определение 1.18. Последовательность {xk} e X называется

минимизирующей (максимизирующей) для функции f(x) на множестве X, если

Jim /(**)= inf /(*) = /* (Jim f(xk) = sup/(x) = /*).

Из определения и существования нижней (верхней) грани функции

f(x) на множестве X следует, что хотя бы одна минимизирующая

(максимизирующая) последовательность гарантированно существует. В самом

деле, если /* = -«>, то найдется последовательность {xk} e X такая, что

lim f(xk) = -©о = /*. Если/*> -©о, то согласно определению 1.3 нижней грани

£->оо

для любого номера k > О существует точка xk, для которой

/.</(*,)</,+р k = l,2,....

Отсюда следует, что \imf(xk) = f*. Аналогично, опираясь на определе-

k—>oo

ние 1.7 верхней грани, можно построить максимизирующую

последовательность.

Определение 1.19. Скажем, что последовательность {xk} сходится

к непустому множеству X, если Нтр(х^,Х) = 0, где р(и,Х) = inf \\u-x\\ —

k—>оо ХЕХ

расстояние от точки и е Еп до множества X.

Лемма 1.2. Пусть X — произвольное непустое множество из Еп,

р(г/, X) = inf \\и - х\\ — расстояние от точки и е Еп до множества X. Тогда

хеХ

справедливо неравенство

\p(u,X)-p(v,XJ[<\\u-v\\ \/u,veEn. (1.5)

Доказательство

Прежде всего из соотношений р(г/, w) = \\и - w\\ > 0 и р(г/,Х)<||г/-гИ|

(w g X) следует, что функция р(г/, X) неотрицательна и конечна во всех

точках и е Еп. Возьмем произвольное число 6 > 0. По определению нижней

грани для любых и, v е Еп найдутся точки uv vE e X такие, что

р(г/, X) < р(г/, и£) < р(г/, X) + 8, р(р, X) < p(v, v£) < p(v, X) + 8.

Из этих неравенств с помощью неравенства треугольника р(г/, vE) < р(г/, v) +

+ p(v, v£) и того, что р(г/, X) < р(г/, vE), имеем

р(г/, X) - р(р, X) < р(г/, v£) - p(v, v£) + e< р(г/, v) + 8.

Аналогично получается неравенство

р(г/, X) - p(v, X) > р(г/, щ ) - 8 - р(я, щ ) > -р(г/, и) - 8.

28

Объединяя последние два неравенства, имеем | р(г/, X) - p(v, X)\ <

< р(г/, v) + 8. Отсюда, переходя к пределу при 8 —» +0, получаем требуемое

неравенство. ■

Из неравенства (1.5) следует, что lim p(vk, X) = p(v, X) для любой после-

£->оо

довательности {vk}, сходящейся к точке v, т.е. функция р(и, X) непрерывна

по и в любой точке v e Еп.

Теперь мы можем сформулировать и доказать расширенную теорему

Вейерштрасса.

Теорема 1.2. Пусть X — компактное множество из Еп, а функция f(x)

определена и полунепрерывна снизу (сверху) на X. Тогда

/• = inf/(*) > — (/* = sup/(x) < +oo),

хеХ хеХ

множество X* = {х е X:f(x) = /*} (X* ={хе X:f(x) = /*}) непусто,

компактно и любая минимизирующая (максимизирующая) последовательность

сходится к X* (X*).

Доказательство

Рассмотрим вариант теоремы, касающийся задачи минимизации. Как

было показано выше, гарантированно существует хотя бы одна

минимизирующая последовательность {xk}, т.е. xke X,k= \, 2, ..., lim f(xk) = /*. Рас-

£->оо

смотрим любую из них. Так как X — компактное множество, то {xk} имеет

хотя бы одну предельную точку и все ее предельные точки принадлежат X.

Возьмем любую предельную точку х* этой последовательности. Тогда

существует подпоследовательность {xk }, сходящаяся к точке х*.

Пользуясь свойством нижней грани /* и полунепрерывностью снизу функции

f(x) в точке х*, имеем /* < f(x*)< lim f(xk ) = lim f(xk) = /*, т.е. f(x*) = /*.

Отсюда следует, что /* > -oo, X* Ф 0, а любая предельная точка любой

минимизирующей последовательности лежит в X*.

Докажем, что X* компактно. Возьмем любую последовательность {vk}e X*.

Так как {vk} e X — компактному множеству, то существует ее

подпоследовательность {vk }, сходящаяся к некоторой точке v* e X. Но {vk} —

минимизирующая последовательность, так как f(vk) = /*, k = 1, 2,.... По доказанному

выше тогда и* е X*, значит, X* — компактно.

Наконец, покажем, что любая минимизирующая последовательность

{xk} сходится к X*. Так как p(xk, X*) = inf p(xk, x) > 0, k = 1, 2,..., то ясно, что

хеХ*

Итр(^,Х*)>0. Пусть Нтр(х^,Х*)= lim p(xk ,Х*) = я<+оо. В силу ком-

пактности X из {xk } можно выбрать подпоследовательность, сходящуюся

к некоторой точке х*. Не умаляя общности, можем считать, что сама

последовательность {xk } сходится к х* (чтобы не переходить к тройной

индексации). Согласно лемме 1.2 функция р(х, X*) непрерывна по переменной х,

поэтому lim p(xk , X*) = р(х*, Х*) = а. Однако по доказанному ранее х* е X*.

т—>оо т

Тогда а - р(х*, X*) = 0. Это значит, что lim p(xk, X*) = lim p(xk, X*) = 0. Сле-

довательно, предел Нтр(х^,Х*) существует и равен нулю.

k—>oo

29

Вариант этой теоремы, относящийся к задаче максимизации f(x) на X,

доказывается аналогично и опирается на соотношения (1.3), (1.4).

Теорема 1.2 доказана. ■

В теореме 1.2 сформулированы достаточные условия, гарантирующие,

что в задачах (1.1), (1.2) нижняя и верхняя грани целевой функции/(х)

на допустимом множестве X достигаются хотя бы в одной точке.

Разумеется, отдельные утверждения этой теоремы остаются справедливыми

и при нарушении некоторых ее условий, о чем свидетельствуют при-

2\\х\\

меры 1.1—1.4. В частности, в примере 1.1 функция f(x) = непре-

1+Ыг

рывна на множестве Хх = Еп, но это множество не является компактным

(оно замкнуто, но не ограничено). Тем не менее здесь /* = О, X* = {х = 0} Ф 0,

т.е. часть утверждений теоремы 1.2 справедлива, однако существуют

минимизирующие последовательности

, R = 1, Z,..., Xfe = \ку лс,..., к), R = 1, Z,...,

первая из которых сходится к X*, а вторая — нет.

1.2.3. Теорема Вейерштрасса для некомпактных множеств

Заметим, что в теоремах 1.1, 1.2 условие компактности множества X

является довольно жестким. Приведем две теоремы, которые также будем

называть теоремами Вейерштрасса, но в которых компактность

множества X не предполагается, зато функция f(x), кроме полунепрерывности

на X, удовлетворяет некоторым дополнительным требованиям.

Теорема 1.3. Пусть X — непустое замкнутое множество из Еп, функция

f(x) полунепрерывна снизу (сверху) наХи для некоторой точки v e X

множество Лебега

M(v) = {xeX: f(x) < f(v)} (M,(v) = {xeX: f(x) > f(v)})

ограничено. Тогда /* > -°° (/* < +°°), множество X* (X*) непусто, компактно

и содержится в множестве M(v) (M{(v)), любая минимизирующая

(максимизирующая) последовательность {xk}, принадлежащая множеству M(v)

(Mf (а)), сходится к множеству X*.

Доказательство

Рассмотрим вариант этой теоремы, касающийся задачи минимизации.

По определению множества M(v) имеем: f(x) > f(v) при всех х е X \ M(v)

и f(x) < f(v) при всех х е M(v). Это значит, что на X \ M(v) функция f(x)

не может достигать своей нижней грани на X и для доказательства теоремы

достаточно рассмотреть функцию f(x) на множестве M(v).

По лемме 1.1 множество M(v) замкнуто, из его замкнутости и

ограниченности следует его компактность. Применяя к эквивалентной исходной

задаче минимизации

f(x) —> min, x e M(v)

теорему 1.2, получим все утверждения теоремы, относящиеся к задаче

минимизации функции f(x) на множестве X. Подчеркнем, что в этой теоре-

30

г(1)_

ме утверждается сходимость к X* только тех минимизирующих

последовательностей {xk}, которые принадлежат M(v). В случае f(v) > /* условие

{xk} е M(v) можно не оговаривать, так для любой минимизирующей

последовательности {xk} найдется номер k0 такой, чтоДл^) <f(v) для всех k > k0,

т.е. xk g M(v) при k > k$. Если же f(v) = /*, то X* = M(v), и в этом случае

могут существовать минимизирующие последовательности, которые не

принадлежат M(v) и не сходятся к X*. Для обоснования этого факта достаточно

вернуться к примеру 1.1 и положить v = 0. Тогда, очевидно, M(v) = {0},

последовательность xk= (k, k,..., k), & = 1, 2,..., будет минимизирующей, не

содержащейся в M(v) и не сходящейся к X*.

Вариант теоремы 1.3, касающийся задачи максимизации функции/(х)

на множестве X, доказывается и комментируется аналогично, с опорой

на соотношения (1.3), (1.4), связывающие задачи минимизации и

максимизации. ■

Теорема 1.4. Пусть X — непустое замкнутое множество из Еп, функция

f(x) полунепрерывна снизу (сверху) на X и для любой последовательности

{xk} e X такой, что lim \хЛ = +°°, справедливо равенство

limf(xk) = +оо (lim f(xk) = -~).

k—>°o k—>°o

Тогда /* > -°° (/* < +°°), множество X* (X*) непусто, компактно и любая

минимизирующая (максимизирующая) последовательность {xk} сходится

кХ*(Х*).

Доказательство

Рассмотрим вариант теоремы, касающийся задачи минимизации.

Заметим, что если множество X ограничено, то все утверждения теоремы

следуют из теоремы 1.2. Поэтому пусть X неограничено, т.е. существует хотя

бы одна последовательность {vk} е X такая, что lim lb J = +«>. Тогда согласно

условию теоремы lim/(^) = +oo. Возьмем какую-либо точку v e X такую,

£->оо

что f(v) > f* (например, можно принять v - vk при достаточно большом k),

и рассмотрим множество Лебега M(v) = {х е X : f(x) < f(v)}. Допустим,

что множество M(v) неограничено, тогда существует последовательность

{wk} e M(v) такая, что lim|UJ + °°. В этом случае Нт/(г^) = +°°, что про-

тиворечит неравенству f(wk)<f(v)<+o°, вытекающему из включения

wke M(v), k=\,2,.... Таким образом, множество M(v) ограничено. Отсюда

и из теоремы 1.3 следуют все утверждения теоремы 1.4.

Для задачи максимизации доказательство проводится аналогично. ■

Еще одно обобщение теоремы Вейерштрасса можно найти в

упражнении 1.17 к этой главе.

Следует заметить, что теоремы 1.1—1.4 Вейерштрасса неконструктивны:

они лишь утверждают, что величины /* или /* конечны, а множества X*, X*

непусты, но они не содержат в себе методы вычисления указанных

величин, нахождения точек экстремума. Тем не менее ценность этих теорем

в том, что они гарантируют разрешимость задач оптимизации (1.1), (1.2).

Более того, они подсказывают, что одним из методов получения прибли-

31

женного решения этих задач является построение минимизирующих

(максимизирующих) последовательностей. Конкретные способы этих

построений будут рассмотрены в гл. 4.

1.3. Задачи безусловной оптимизации. Классический метод

1.3.1. Описание метода

Рассмотрим задачу поиска локального или глобального экстремума

гладкой функции многих переменных на всем пространстве Еп. Такую

задачу принято называть задачей на безусловный экстремум или задачей

безусловной оптимизации. В этом термине отражен тот факт, что на

переменные х = (х1,..., хп) никакие дополнительные ограничения в такой задаче

не накладываются. Если необходимо искать только точки минимума или

точки максимума, то такую задачу называют задачей безусловной

минимизации или безусловной максимизации соответственно.

Задачи безусловной оптимизации часто возникают при обработке

результатов экспериментов, измерений, наблюдений за какими-либо

физическими, экономическими процессами. Предположим, что

наблюдаемый процесс характеризуется набором параметров х = (х1, х2, ..., х*) е Еп,

а результатом является действительное число у. Пусть проведено т

наблюдений и получены числа ур соответствующие параметрам Xj =(xj,...,xp,

7=1,..., т. Точная зависимость между х и у нам неизвестна, но имеющийся

у нас опыт наблюдений дает нам основание предполагать, что эта

зависимость описывается функцией вида у = ф(х, а), зависящей от числовых

параметров а = (av ..., as). Тогда естественно попытаться подобрать параметры а

так, чтобы зависимость указанного вида наилучшим образом

аппроксимировала результаты наблюдений уь ..., ут. В качестве меры точности

наблюдений часто берут функцию

т

f(a)=l(yj-q>(xpa))2. (1-6)

7=1

Наилучшим считается такое значение параметров а = (av ..., as) e Es,

при котором функция f(x) принимает наименьшее значение на Es.

Обработка результатов наблюдений на основе минимизации функции (1.6)

называется методом наименьших квадратов.

В качестве аппроксимирующей функции ф(х, а) в формуле (1.6) нередко

берут линейную функцию (s = п):

ф(х, а) = {а, х) = аххх +... + а^12. (1.7)

Во многих экономико-математических моделях вводится понятие

производственной функции у = ф(х, а), где у — объем производства, х = (х1, ...,

хп) — вектор используемых ресурсов. Наиболее известным примером

производственной функции служит функция Кобба — Дугласа

y = AY[(xJ)aJ =A(x1)ai(x2)a2 '...-{хп)ап, ^ = const>0.

7=1

32

При построении такой функции для конкретного экономического

объекта числовые параметры аь ..., ап оценивают по статистическим данным

о значениях у и х = (х1,..., хп) за предыдущие периоды времени.

В качестве меры точности наблюдений вместо функции (1.6) могут быть

использованы и другие функции, например

j.

( т Лр

/(*) = 2(У;-Ф(*;>я))р ,р>1,или/(й)=тах|г/,-ф(х-,й)|. (1.8)

Задачи минимизаций функций (1.6)—(1.8) по переменной а на

множестве Es являются задачами безусловной оптимизации.

Кратко изложим классический метод поиска решения задач на

безусловный экстремум, подразумевая под этим тот подход к ним, который основан

на дифференциальном исчислении функций многих переменных и обычно

излагается в учебниках по математическому анализу [22, 29].

Сначала напомним некоторые понятия и факты.

Определение 1.20. Пусть функция/(х) определена в некоторой малой

6-окрестности 0(х, е) = {v е Еп : \\v -х\\ < г} точки х. Говорят, что функция

f(x) дифференцируема в точке х, если существует вектор f\x) e Еп такой,

что приращение функции можно представить в виде

д/(х) = f(x + А) - f{x) = </'(*)> h) + о(й, x) \/h : \\h\\ < e, (1.9)

где o(h, x) — величина, бесконечно малая более высокого порядка, чем || h ||,

|о(А,х)|

что означает lim ' „ ., ' = 0. Вектор f'(x) называется первой производной

11а||->о \\п\\

или градиентом функции / в точке х.

Условие (1.9) однозначно определяет градиент /'(*)> причем

ВДх)

/'(х) = (/;1(х),...,/;„(^))т, где К(х) = Ц£1, i = i,...,n. (1.10)

Таким образом, если функция дифференцируема в точке х, то она

необходимо обладает частными производными в этой точке. Обратное, однако,

неверно: наличие частных производных для функций многих переменных

(п > 2) не гарантирует дифференцируемость функции. Например, функция

fix1, x2) = vk1*2! имеет частные производные

/;,(0,0)= lim ^ ^^ = 0;

JO-(0 + Ar2)|-Vo^O

/;2(0,0)= lim Я-± -^ = 0,

х Д*2-»0 ДГ2

однако для этой функции не выполнено равенство (1.9) при h = (/г1, /г2),

А1 = А2;

J(0+^)(0+^)| = \hy I = 4-llAll ф о(||А||).

33

В этом примере частные производные в точке (0; 0) терпят разрыв.

Достаточным условием дифференцируемости функции/в точке л: является

существование и непрерывность частных производных в этой точке [22, 29].

Если функция дифференцируема в каждой точке множества X, то ее

часто называют гладкой на X. Если производная f\x) существует и

непрерывна в каждой точке хе Х,то функцию/(х) называют непрерывно

дифференцируемой на множестве X. Напомним, что функция, дифференцируемая

в точке х, непрерывна в этой точке.

Определение 1.21. Пусть функция/(х) определена и дифференцируема

во всех точках некоторой е-окрестности точки х. Говорят, что функция/(х)

дважды дифференцируема в точке х, если существует матрица f"(x)

размера п х п такая, что

/'(* + Л) - /'(*) = f'\x)h + ox (А, х) \/h: \\h\\ < е,

(1.11)

i lk(A>*)l

где Km -—й-jj—- = 0. Матрица j(x) называется второй производной, или

||А||—>о \\п\\

гессианом, функции / в точке х.

Условие (1.11) однозначно определяет вторую производную/"(г), причем

7*1*1 С*) fx'lx2(X) - fx'lxn(X)

f'2Y\(x) /'L2CO - Jr2Yn(X)

/"(*)=

Э2/(*)_ Э (df(x)

= {fZrj(x),i,j = U,n}, (1.12)

Jxnxn \X)j

3 (

Э/(*)

Эх1'

вторая частная производ-

где Л- ,•(#) =— =—г, . ,

•/*'*;V ' dxldxJ дх1^ dxJ ) dxJ\

ная функции/(х) по переменным дг1', хК Известно [22, 29], что/"(.г) —

симметричная матрица.

Если функция f(x) дифференцируема в некоторой е-окрестности

точки х, а в самой точке х существует ее вторая производная, то

справедлива формула Тейлора

f(x + h)-f(x)= {f'(x),h)+-{f"(x)Kh) + o2(Kx) VA:||A||<e, (1.13)

где lim

W-x>

\o2(h,x)\

! r—0. Остаточный член в формуле Тейлора взят в форме

Пеано — этого нам будет достаточно в дальнейшем. Заметим попутно, что

другие формы остаточного члена, уточняющие его оценку, накладывают

на функцию/(г) более жесткие условия [22, 29].

Квадратичную форму

d2f(x) = (f"(x)h,h)= %Щ^к*Ы

i j=i oxlaxJ

переменной h = (Л1, ..., hn) e En называют вторым дифференциалом

функции / в точке х. Если функция дважды дифференцируема в каждой точке

34

множества X, то ее часто называют дважды гладкой на X. Если вторая

производная f'(x) существует и непрерывна в каждой точке х е X, то

функцию/(х) называют дважды непрерывно дифференцируемой на множестве X.

Определение 1.22. Пусть А = {а^ i,j = 1,..., п} — симметричная матрица

п

размера п х п, (Ah,h) = £ а^Ы — соответствующая ей квадратичная

форма. Говорят, что матрица А положительно (неотрицательно)

определена на Еп и обозначают А > О (А > 0), если

(Ah,h)>0 ((Ah,h)> 0) \/heEn,h*0 (\/heEn).

Аналогично матрица А отрицательно (неположительно) определена

на Еп, т.е. А < 0 (А < 0), если

(Ah,h)<0 ((Ah,h)<0) \/heEn,hФ0 (\/heEn).

Перейдем к изложению необходимых и достаточных условий

оптимальности в задачах на безусловный экстремум.

Теорема 1.5 (необходимое условие экстремума). Пусть х* — точка

локального экстремума (минимума или максимума) функции f(x) на Еп,

a f(x) дифференцируема в точке х*. Тогда

/'(*.) = <>. (1.14)

Если/(х) дифференцируема в некоторой г-окрестности 0(х*, б) точки х*

и дважды дифференцируема в точке х*, то /"(**)>0 в точке локального

минимума и f"(x*)< 0 в точке локального максимума.

Доказательство

Пусть для определенности х* — точка локального минимума

функции f(x) на Еп. Это значит, что существует 8-окрестность 0(х*,Ь) точки х*

такая, что f(x) > f(x*) \/х е 0(х*, 8). Отсюда и из формулы (1.9) при х = х*,

h = -tf'(x*), 0 < t < t0, где число t0 столь мало, что t0 \f'(x*)\\ < 8, имеем

0 < </'(*.)." */'(*•)> + o(t) = -t\fXx. )f + o(t).

Разделим это неравенство на t > 0 и затем устремим t —» +0. Получим

-|/'(**)| > 0, что возможно только при выполнении равенства (1.14).

Далее, пусть/(х) дифференцируема в окрестности 0(х*,е) и дважды

дифференцируема в точке х*. Зафиксируем произвольное h e Еп и

возьмем t0> 0 столь малым, что t0 \\h\\ < г. Тогда х = х* + th e 0(х*,г) и из формулы

(1.13) с учетом уже доказанного равенства (1.14) имеем

0<f(x. +th)-f(x*) = -(f"(x*)th,th) + o(t2) \/t:0<t<t0.

Разделив это неравенство на t2 и устремив t —»+0, находим 0 < (f"(x* )h, h)

V h g En. Согласно определению 1.22 это значит, что /"(#*) >0. Так как

точка локального максимума функции f(x) является точкой локального

минимума функции (-f(x)), то, применяя уже доказанные утверждения

теоремы к функции (-f(x)), получим, что если х* — точка локального

максимума/^) на Еп, то f'(x*) = 0, f"(x*) < 0. ■

35

Определение 1.23. Точка v, удовлетворяющая уравнению f'(v) = О,

называется стационарной точкой функции/(х).

Из теоремы 1.5 следует, что в задаче безусловной оптимизации только

стационарные точки могут быть точками экстремума дифференцируемой

на Еп функции. Однако стационарная точка не всегда является точкой

экстремума. Более того, даже если в стационарной точке v выполняется

условие f"(v) > О (f"(v) < 0), то и это не значит, что точка v непременно

является точкой локального минимума (максимума). Можно уверенно сказать

лишь одно: если функция/(х) дифференцируема на Еп, то ее стационарные