Автор: Зайченко Ю.П.

Теги: навчальний посібник інтелектуальні системи проектування нейронні мережи градієнти

ISBN: 966-8407021-0

Год: 2004

Текст

Зайченко Ю.П.

ОСНОВИ

проектування

інтелектуальних

систем

Міністерство освіти і науки України

Зайченко Ю.ГІ.

ОСНОВИ

ПРОЕКТУВАННЯ

ІНТЕЛЕКТУАЛЬНИХ СИСТЕМ

Рекомендовано Міністерством освіти і науки України

як навчальний посібник для студентів

вищих навчальних закладів

Київ 2004

»^¥ДК 004.^9(075.8)

ББК-&Зт843я73

>/3 17

Рекомендовано Міністерством освіти і науки України

як навчальний посібник для студентів вищих навчальних закладів

(лист МЦ/18.2-768 від Ц 04.2004 р.)

Рецензенти: д.т.н., проф. Бідюк П.І. (Національний технічний

університет України «КПІ»):

д т.н., засл. проф. Волков О А. (Національний авіа-

ційний університет України);

д-т.н., проф. Теленик С.Ф. (Національний техніч-

ний університет України «КШ»);

д.т.н., проф. Тоценко В Г. (зав. відділом Інститута

проблем реєстрації інформації НАН України).

З 17 Зайченко Ю.П. Основи проектування інтелектуаль-

них систем. Навчальний посібник. — КТгТЗидавничий

Дім”«Слово», 2004Г— 352 с.

I8ВN 966-8407-21-0

В посібнику розглянуто актуальні напрямки робіт в галузі інтелектуальних

систем. Розглянуто задачі і методи навчання та самонавчання в інтелектуальних

системах. Велику увагу приділено важливому напрямку в галузі ІС-пітучним ней-

ронним мережам. Розглянуто та проаналізовано методи навчання нейромереж:

генетичний, градієнтні методи, метод спряжених градієнтів та інші. Крім класич-

них нейромереж в посібнику розглянуто новий перспективний клас нейроме-

реж— нечіткі нейромережі, їх властивості, алгоритми навчання та самонавчання.

Застосування нечітких мереж ілюструється численними прикладами в задачах

класифікації, кластер-аналізу та прогнозування в макроекономіці. Розглянуто

також перспективний метод самоорганізації моделей складних систем — так зва-

ний метод МГУА, а також його новий варіант — нечіткий МГУА, запропонова-

ний в роботах автора. Ці методи дістали широке використання в задачах

моделювання та прогнозування.

Особливістю навчального посібника є те, що він містить багато прикладів

застосування методів ІС иейронних мереж та МГУА в задачах класифікації та

.моделювання в економіці, які є оригінальними і раніше в монографіях не вис-

вітлювались.

Підручник розраховано насамперед на студентів ВНЗ різних напрямів,

зокрема «Комп’ютерні науки», «Прикладна математика», він буде корисний та-

кож і спеціалістам, що займаються розробкою та експлуатацією систем штучного

інтелекту.

І8ВМ 966-8407-21-0

© Ю.П. Зайченко, 2004

© Видавничий Дім «Слово», 2004

ПЕРЕДМОВА

Навчальний посібник «Основи проектування інтелекту-

альних систем» підготовлено на базі курсу лекцій з цієї

дисципліни, які автор протягом майже 10 років читає

для студентів напряму «Комп’ютерні науки» спеціальності

«Інтелектуальні системи прийняття рішень» в економіці і бі-

знесі в Інституті прикладного системного аналізу при НТУУ

«КПІ».

У посібнику розглянуті важливі напрями робіт у галузі

інтелектуальних систем (ІС), а саме моделі й методи розпі-

знавання образів і класифікації, моделі і алгоритми навчан-

ня та самонавчання в ІС. Богато уваги приділено розгляду

основних напрямів робіт в галузі нейронних мереж, включа-

ючи НМ зі зворотним поширенням помилки, методи і алгори-

тми навчання нейронних мереж, нейронні мережі Хопфілда,

Хемінга, нейронна мережа Кохонена та алгоритми її самоор-

ганізації. Значна увага приділена розгляду нечітких інтеле-

ктуальних систем та нечітких нейромереж, основам їх фун-

кціонування та застосування.

4

ПЕРЕДМОВА

Четверта глава присвячена цікавому та перспективному

напряму в галузі систем штучного інтелекту — індуктивно-

му методу самоорганізації складних систем, так званому «ме-

тоду групового урахування аргументів» (МГУА). Тут роз-

глянуті основні принципи та ідеї МГУА, поліноміальний та

комбінаторний алгоритми МГУА, їхні властивості. Крім тра-

диційних алгоритмів МГУА, у посібнику розглянуто нові ал-

горитми МГУА з нечіткою логікою. В цьому розділі відобра-

жені оригінальні результати автора по нечіткому алгоритму

МГУА та його застосуванню для прогнозування макроеко-

номічних показників. Остання глава посібника присвячена

викладенню основ еволюційного моделювання та генетичних

алгоритмів і їх застосуванню в розробці моделей складних ін-

телектуальних систем прийняття рішень, зокрема в задачах

розпізнавання образів та класифікації.

Слід зазначити, що в навчальному посібнику, крім тра-

диційних та широко відомих напрямів робіт в різних галузях

систем штучного інтелекту, знайшли відображення також до-

слідження автора в галузі нейронних мереж, нечітких інте-

лектуальних систем та нечіткого методу самоорганізації та їх

застосування в сфері прогнозування в макроекономіці.

Навчальний посібник розраховано на студентів напряму

«Комп’ютерні науки», він буде корисним і для фахівців, що

працюють в області систем штучного інтелекту.

Професор НТУУ «КПІ» Зайченко Ю.П.

ВСТУП

Основні поняття та визначення.

Основні напрямки робіт в галузі

систем штучного інтелекту

Сучасний етап розвитку систем підтримки прийняття рі-

шень характеризується все більшою інтелектуалізацією про-

цесів прийняття рішень, причому процес автоматизації твор-

чих процесів прийняття рішень йде як ушир, так і углиб, охо-

плюючи все нові та нові сфери, які раніше вважалися цілком

прерогативою людини.

Зараз існує багато визначень системи штучного інтелекту.

Дамо одне з них, не претендуючи на вичерпну повноту.

Системою штучного інтелекту називається людино-ма-

шинна система, яка використовується для автоматизації про-

цесів творчої діяльності людини в різних сферах, зокрема

прийнятті рішень.

Зробимо коротенький огляд історії робіт в галузі систем

штучного інтелекту (ШІ).

Термін штучний інтелект (агіійсіаі іпіеііі^епсе) вперше

був запропонований в 1956 році на семінар із аналогічною

назвою в Дартмутському коледжі в США [5|. Семінар було

присвячено розробці методів розв’язання логічних задач (в

протилежність обчислювальним).

І2

6

ВСТУП

Невдовзі після визнання ШІ окремою галуззю науки від-

булося її розділення на 2 напрямки робіт — нейрокібернсти-

ку та кібернетику «чорної шухляди» (Ьіаск Ьох) [5]. Основну

ідею першого напрямку можна сформулювати таким чином:

єдиний в світі об’єкт, здатний мислити — цс людський мозок,

тому будь-який об’єкт (система), яка має на мсті реалізувати

процеси мислення, повинна відтворювати структуру мозку.

Отже нсйрокібсрнстика орієнтована на апаратно-прог-

рамне моделювання структур, подібних до структури люд-

ського мозку.

Основою для цього напрямку робіт були дослідження ней-

рофізіологів по вивченню структури та функцій мозку. В ре-

зультаті цих досліджень з’явилися перші наукові роботи по

штучним пейронним мережам, які складаються з множини

(набору) нейроподібних елементів.

Перші дослідження нейронних мереж були виконані Мак-

Калоком (1956р.) та Фр. Розенблатом (1962р.). Фр. Розсн-

блат створив нейронну мережу, яка моделювала роботу си-

стеми людського зору — «око-зоровий центр мозку» — і отри-

мала назву перцептрон (від латинського слова «регссрііо» —

сприйняття). Перцептрон складається з 3-х типів нейронів:

5-елемснтів (сенсорних), що перетворюють оптичні сигнали

на електричні; Л-елементів (асоціативних), які оброблюють

сигнали від 5-слсмснтів і виконують аналіз зорової інформа-

ції; Я-елсментів (реагуючих), які виконують класифікацію.

Проведені Фр. Розенблатом досліди з перцептроном показа-

ли його здатність розпізнавати прості геометричні фігури, а

також латинські букви. Тобто, перцептрон дійсно може слу-

жити моделлю роботи зорової системи людини. Ці піонер-

ські дослідження Фр. Розснблата були підхоплені багатьма

вченими в різних країнах світу і дали початок новому на-

уковому напряму з нейронних мереж. Проте згодом, після

наступних досліджень були виявлені суттєві недоліки три-

шарового перцептрона, зокрема його нездатність виконувати

функції абстрагування та екстраполяції зображень, за якими

ВСТУП

7

проводилися навчання, на інші подібні зображення, а також

відсутність інваріантності до зсуву та повороту зображень

(об’єктів). Теоретичні дослідження математиків Мінського та

Новікова показали суттєво обмеженість можливостей перце-

птронів, зокрема по розпізнаванню зображень. В результаті

весь напрямок по нейромережам перцептронного типу був

підданий нищівній критиці з боку математиків, і роботи в

напрямку нейромереж були необгрунтовано припинені на 10

років.

Лише в середині 80-х років вони були знову відновлені, і

зараз цей напрямок переживає новий бум.

У 1980-х роках в Японії в рамках проекту ЕОМ 5-го по-

коління був створений перший нейрокомп’ютер. На цей чаз

обмеження по ємності пам’яті та швидкодії комп’ютерів бу-

ли практично зняті. З’явилися так звані «трансп’ютери» —

мікроЕОМ з великим числом паралельних процесорів. Вони

почали широко використовуватися в нейромережах

Можна виділити 3 підходи до створення нейронних.ме-

реж: 1) апаратний; 2) програмний; 3) гібридний.

Апаратний підхід базується на розробці інтегральних

схем, в яких відтворюється структура нейронноі мережі. В

останні роки з’явилось багато фірм, які розробляють та виго-

товляють нейрочіпи, де реалізована паралельна архітектура

нейромережі.

Програмний підхід пов’язаний з розробкою програмних

моделей нейромереж на звичайних ЕОМ. Основною областю

застосування нейрокомп’ютерів стали системи розпізнавання

образів.

Кібернетика «чорної шухляди». В основу цього підходу

покладено такий принцип: «Не суттєво, як влаштована інте-

лектуальна система. Головне, щоб на задані вхідні стимули

(сигнали) вона реагувала так само, як і людський мозок».

Цей напрямок спочатку був орієнтований на пошук алгори-

тмів рішення інтелектуальних задач на існуючих на той час

комп’ютерах.

1**

8

ВСТУП

Суттєвий внесок в становлення нової науки (напрямку)

внесли такі вчені, як МакКарті, автор першої мови програ-

мування для задач штучного інтелекту — ЛІСП, та М Мін-

ський, автор ідеї та винахідник фрейма та фреймової моделі

представлення знань.

В середині 60-х та 70-х років проводились інтенсивні по-

шуки моделей та алгоритмів, здатних вирішувати інтелекту-

альні творчі задачі. В 60-і роки народилась ідея лабіринтного

пошуку, з’явились перші програми для гри в шахи та шашки.

60-70-і роки — це епоха розвитку евристичного програмува-

ння. Родоначальниками цього цікавого напрямку були вчені

Ньюелл, Саймон та Шоу, які розробили систему СР8 (^епегаї

ргоЬІет воіуєг) — загальний вирішувач задач. Ця система бу-

ла з успіхом застосована для пошуку доведень теорем з ев-

клідової геометрії на основі системи аксіом.

Програма СР8 при пошуку доведень теорем використовує

так звані «евристики» — це прийоми для скорочення числа

вариантів просмотру, якими користується людина. Програма

СР8 виявилась дуже ефективною і знайшла доведення не

тільки всіх теорем планіметрії, а майже усіх теорем з розділу

математичної логіки — обчислення висловлювань.

Евристичне програмування та ідеї програми СР8 були з

успіхом використані і в інших розділах математики, зокре-

ма математичної логіки, для автоматичного пошуку доведень

теорем в 70-і роки. В цей же час Робінсон розробив метод

резолюцій, який дозволяє автоматично доводити теореми з

наявного набору аксіом. На основі методу резолюцій Альбер

Кальмерое в 1973 р. створив мову логічного програмування

ПРОЛОГ. Одночасно радянський математик Ю.С.Маслов

запропонував метод зворотного висновку, який дозволяє зна-

йти рішення логічних задач, рухаючись від кінця (наслідку)

до початку (посилання).

Приблизно в цей же час суттєвий прорив в галузі ШІ було

зроблено в США, де в середині 70-х років на зміну пошуку

універсальних алгоритмів мислення виникла ідея моделюва-

ВСТУП

9

ти конкретні знання фахівців-експертів. В США з’явились

перші експертні системи (ЕС), що базуються на знаннях, бу-

ли створені ЕС МУСШ (1976) та БЕКОНАЬ (1978); в ре-

зультаті яких виник та почав застосовуватися новий підхід

до вирішення задач ШІ, заснований на представленні знань.

Наприкінці 70-х років у сферу штучного інтелекту актив-

но вторгається Японія, яка об’явила про початок проекту

ЕОМ 5-го покоління. Цей проект був розрахований на 10 ро-

ків і об’єднав зусилля кращих молодих спеціалістів провідних

компаній Японії в галузі комп’ютерів.

В результаті було створено перший нейрокомп’ютер та

перші інтелектуальні роботи.

Історія досліджень в галузі штучного інтелекту в Радян-

ському Союзі.

В 1954 році в СРСР в МДУ ім. Ломоносова почав пра-

цювати перший семінар «Автомати і мислення» під керівни-

цтвом академіка А.А. Ляпунова. Проводяться численні робо-

ти в царині розпізнавання зображень, мови.

В 1974 році створено Наукову Раду з проблеми штучно-

го інтелекту при Президії АН СРСР, яку очолив академік

Г.С. Поспелов. З ініціативи Ради було започатковано 5 ком-

плексних наукових проектів під керівництвом провідних вче-

них в сфері ШІ, а саме:

ДІАЛОГ — роботи по розумінню натуральної мови — ке-

рівник А.П. Єршов;

СИТУАЦІЯ — ситуаційне керування — керівник Д.О. Пос-

пелов;

БАНК — створення банків даних та знань — керівник

Л.Т. Кузін;

КОНСТРУКТОР — автоматизація конструкторського

проектування — керівник О.І. Половінкін;

ІНТЕЛЕКТ РОБОТА — проектування інтелектуальних

роботів — керівник Д. Охоцімський.

В 80-і роки проводяться активні дослідження в галузі екс-

пертних систем. В 1988 році створено асоціацію штучного

Р

10

ВСТУП

інтелекту в СРСР, до складу якої увійшли понад 300 вче-

них. Президентом асоціації було обрано професора Д О. Пос-

пелова, відзначаючи його винятковий вклад в розвиток бага-

тьох напрямків в галузі ШІ

В Україні наукові дослідження у сфері штучного інтеле-

кту сконцентрувалися в Інституті кібернетики ПАНУ. Тут

в 70-80-ірр. проводили роботи по створенню нових методів,

алгоритмів розпізнавання зображень професори В.А. Кова-

левський, М.І. Шлезінгер, В.І. Рибак та інші. В сфері роз-

пізнавання мовних сигналів значний внесок зробив профе-

сор Т.К. Вінцюк. Результати їх робіт відомі далеко за межа-

ми України. Значний внесок в розвиток ряду перспективних

напрямків досліджень в сфері ШІ зробив академік НАНУ

О.Г. Івахненко та його учні, які ще в 70-і роки розробили нові

алгоритми навчання та самонавчання розпізнаючих систем,

що знайшли відображення в численних монографіях.

Особливо слід відзначити вклад О.Г. Івахненка в створен-

ня принципово нового методу індуктивного моделювання

складних систем — МГУА, який вже понад ЗО років з успіхом

використовується не тільки в Україні, але й у провідних за-

рубіжних країнах (США, Японія, Німеччіна) для розробки

моделей складних інтелектуальних систем.

В галузі моделювання мислення та психіки цікаві дослі-

дження були виконані під керівництвом академіка М.М. Амо-

сова, де було розроблено одну з перших моделей психіки та

мислення з урахуванням емоціональної сфери. Слід визна-

чити значний внесок в галузь нейронних мереж та нейро-

комп’ютерів вчених Кібернетичного центру НАНУ, зокрема

Е.М. Куссуля, Б. Резніката інших. В області розробки інтеле-

ктуальних систем планування дій на протязі багатьох років

плідно працює В.П. Гладун.

В останні 2 роки вченими Кібернетичного центру започа-

тковано нову комплексну програму НАН України «Образний

комп’ютер», основні цілі якої — розробка та впровадження

комп’ютерів, заснованих на принципах ШІ, які будуть здатні

ВСТУП

11

оперувати не тільки даними в числовій формі, а й образа-

ми — візуальними та мовними. Керівник програми — профе-

сор Т.К. Вінцюк.

Як видно з цього огляду історії розвитку штучного інтеле-

кту, на даний час це перспективна галузь науки, що швидко

розвивається та має багато напрямків.

Виділимо деякі основні з них напрямків.

1. Представлення знань, маніпуляція знаннями та ство-

рення експертних систем.

2. Спілкування, комунікації «людина-машина».

3. Розпізнавання образів.

4. Навчання та самонавчання.

5. Планування дій, пошук розв’язків задач.

6. Нейронні мережі.

7. Самоорганізація, методи евристичної самоорганізації.

8. Генетичні алгоритми та еволюційне моделювання.

9. Автоматизація конструювання та проектування нових

виробів, пошук винаходів за допомогою ЕОМ.

Дамо коротеньку характеристику деяких з цих напрямків.

1. Представлення знань та маніпулювання знання-

ми. В рамках цього напрямку вирішуються задачі, пов’яза-

ні з формалізацією та представленням знань в пам’яті інте-

лектуальної системи (ІС). Для цього розробляються спеці-

альні моделі представлення знань та мови для опису знань.

Вивчаються джерела, з яких ІС може видобувати знання, і

розробляються процедури, за допомогою яких можливе отри-

мання нових знань. Проблема представлення знань для ІС

дуже актуальна, оскільки ІС — це системи, що спираються

на знання про відповідну предметну сферу.

Для того, щоб користуватися знаннями, необхідно ІС

навчити маніпулювати ними. В рамках цього напрямку

будуються засоби поповнення знань, вивчаються системи

класифікації знань, розробляються процедури узагальнення

знань і формування на їх основі понять. Створюються ме-

тоди правдоподібного виводу нових знань на основі наявних

І ♦ **

12

ВСТУП

з використанням різних правил висновку. Даний напрямок

глибоко пов’язаний із створенням експертних систем.

2. Спілкування. В коло задач цього напрямку входить

проблема розуміння зв’язних текстів на обмеженій та не-

обмеженій природній мові, розуміння мови, синтез мови, тео-

рія комунікацій «людина-машина». До цього ж кола проблем

належать задачі формування пояснень дій інтелектуальної

системи, які вона повинна дати на запит людини. На базі

досліджень в цій сфері створюються методи побудови лінгві-

стичних процесорів, систем діалогового типу.

3. Сприйняття та розпізнавання образів. Розпізна-

вання образів, класифікація відносяться до однієї з найважли-

віших властивостей інтелекту як природного, так і штучного.

Термін розпізнавання образів відноситься в рівній мірі як

до процесів сприйняття та пізнання, так і до класифікації

об’єктів, що спостерігаються.

Метою створення автоматизованих систем розпізнавання

образів є автоматизація процесів сприйняття і пізнання об’єк-

тів, що пов’язано з пошуком, ідентифікацією, класифікацією

та описом образів на основі аналізу реальних даних. В зада-

чі розпізнавання образів можна виділити 2 етапи: 1) аналіз

вхідних об’єктів, їх опис у вихідному просторі ознак, пошук

інформативних ознак, достатніх для правильного розпізна-

вання, та перехід до опису об’єктів у просторі інформатив-

них ознак; 2) класифікація об’єкта, тобто віднесення його до

одного з класів. Для цього розробляються відповідні вирі-

шальні правила класифікації. Слід відзначити, що вхідна ін-

формація про вхідні об’єкти може мати самий різний хара-

ктер: зображення (плоскі та об’ємні), мовні сигнали, електри-

чні, оптичні та інші види сигналів, чисельні послідовності то-

що, деякі сценарії.

4. Навчання. Одна з суттєвих особливостей людського

інтелекту — це здатність до навчання. Під навчанням розу-

міється накопичення досвіду вирішення задач і перенос його

на інші задачі, які досі не вирішувалися.

ВСТУП

13

Для того, щоб це стало можливим, необхідно створити ме-

тоди формування умов задачі по опису проблемної ситуації,

або в результаті спостережень за нею, навчитися переходу від

відомих рішень (розв’язків) часткових задач (прикладів) до

вирішення загальної задачі; створити прийоми (засоби) де-

композиції початкової задачі на більш малі задачі так, щоб

вони виявилися відомими для системи. На цей час існує 2

основних напрямки у сфері навчання ІС (2 типи моделей на-

вчання): перший напрямок базується на асоціативній моделі

навчання, згідно з якою будь-яке навчання є встановленням

асоціативних зв’язків в нейроноподібних структурах; другий

напрямок базується на лабіринтній моделі навчання, згідно

з якою навчання — це процес пошуку напрямку руху в ла-

біринті можливих варіантів (напрямків руху) з оцінюванням

перспективності руху в даному напрямку за деякими локаль-

ними критеріями оцінки.

Важливий клас задач становлять так звані задачі само-

навчання, або навчання без вчителя (поп-еирегуівесі Іеаг-

піп^). До цього класу задач належать задачі кластеризацїї

або кластер-аналізу (сіиеіег-апаїузіз). Ці задачі формулюю-

ться так: є якась вибірка (множина) об’єктів, класифікація

яких невідома, треба розбити цю множину на деякі підмно-

жини (кластери) так, щоб максимізувати (або мінімізувати)

вибраний критерій кластеризацїї. При цьому використовує-

ться вибрана метрика відстані між об’єктами, які належать

до одного кластера.

5. Планування дій рішення задач. Функціонування

багатьох ІС носить цілеспрямований характер (наприклад,

автономні інтелектуальні роботи). Типовим прикладом тако-

го функціонування являється рішення задач планування до-

сягнення поставленої мети із деякої фіксованої вихідної ситу-

ації. Результатом вирішення задачі повинен бути план дії —

частково упорядкована послідовність дій.

Такий план нагадує деякий сценарій (граф), в якому в

якості відношення між вершинами виступають відношення

типу: «ціль — підціль», «ціль — дія», «дія — результат».

14

ВСТУП

Довільний шлях у цьому сценарії, який веде від вершини,

що відповідає початковій ситуації, в довільну цільову верши-

ну визначає план дій.

Пошук плана дій виникає в ІС лише тоді, коли вона зустрі-

чається з нестандартною ситуацією, для якої апріорі нема ві-

домого заздалегідь набора дій. Усі задачі побудови плана дій

можна розділити на 2 класи, яким відповідають різні моделі:

планування в просторі станів (88-проблема) та планування в

просторі задач (РВ-проблсма).

В першому випадку (88-проблема) вважається заданим

деякий простір ситуацій. Опис ситуацій включає стани зов-

нішнього світу та стани ІС. Ситуації утворюють деякі уза-

гальнені стани, а дії ІС призводять до зміни актуалізованих

в даний момент станів. Серед узагальнених станів виділя-

ють початкові стани (зазвичай один) та кінцеві (цільові). 88-

проблема полягає в пошуку шляху, який веде із початкового

стану в один із кінцевих.

При плануванні в просторі задач (РВ-проблема) ситуація

інша. Простір утворюється в результаті введення на множині

задач відношень типу: «частина — ціле», «задача — підзада-

ча», «загальний випадок — частковий випадок». Проблема

планування полягає в пошуку такої декомпозиції вихідної

задачі на підзадачі, яка б приводила к підзадачам, розв’я-

зок яких відомий. Цей метод (підхід) приводить до хороших

результатів тому, що часто рішення задачі має ієрархічну

структуру. Пошук планування в просторі задач полягає в

послідовному зведенні початкової задачі до все більш про-

стих доти, поки не будуть отримані лише елементарні задачі.

Частково впорядкована сукупність таких задач і складає рі-

шення початкової задачі. Дскомпозицію задачі на альтерна-

тивні підмножини підзадач зручно представляти у вигляді

І/АБО-графа. В такому графі будь-яка вершина, крім кінце-

вої, має або кон’юнктивно зв’язані з нею дочірні вершини («I-

вершини»), або диз’юнктивно зв’язані («АБО-вершини»). В

окремому випадку при відсутності «І-вершини» маємо граф

ВСТУП

15

простору станів. Кінцеві вершини являються або заключни-

ми (їм відповідають елементарні задачі), або тупиковими.

Початкова вершина (корінь І/АБО-графа) представляє со-

бою вихідну задачу. Мета пошуку на І/АБО-графі — пока-

зати, що початкова вершина розв’язна. Розв’язними являю-

ться ті заключні «І-всршини», у яких розв’язні усі дочірні,

або «АБО-всршини», у яких розв’язна хоча б одна дочірня.

Розв’язний граф складається з розв’язних вершин і вказує

спосіб розв’язання (розв’язності) для початкової вершини.

Наявність тупикових вершин приводить до нерозв’язних вер-

шин. Нерозв’язними вважаються тупикові І-вершини, у яких

нерозв’язна хоча б одна дочірня, та АБО-всршини, у яких

нерозв’язні усі дочірні.

Існує багато алгоритмів в просторі задач. Розглянемо, на-

приклад, метод ключових операторів. Нехай задана задача

(А, В}, де А — вихідна задача, В — кінцева задача, і нехай ві-

домо, що оператор / обов’язково входить в її рішення. Такий

оператор називається ключовим. Нехай для застосування /

потрібно мати стан С, а результат його застосування є / (С).

Тоді І — вершина породжує 3 дочірні: (А,С)-, та

(/ (С), В), із яких середня являється елементарною задачею.

Далі до задач (А, С) та (/ (С), В) також шукають ключові

оператори, і вказаний процес редукції повторюється доти, по-

ки це можливо. В результаті вихідна задача розбивається на

впорядковану сукупність підзадач (елементарних), для ко-

жної з яких розв’язок розв’язання відомий.

6. Нейронні мережі. Нейронні мережі — один з най-

більш популярних напрям-

ків робіт в області інтелек-

туальних систем, який веде

свій відлік часу з появи пер-

цептрона Фр. Розенблата.

Нейронні мережі складаю-

ться з великого числа

нейроподібних елементів —

Рис. 1. Структура нейрона

16

ВСТУП

формальних нейронів. Кожний нейрон має декілька вхідних

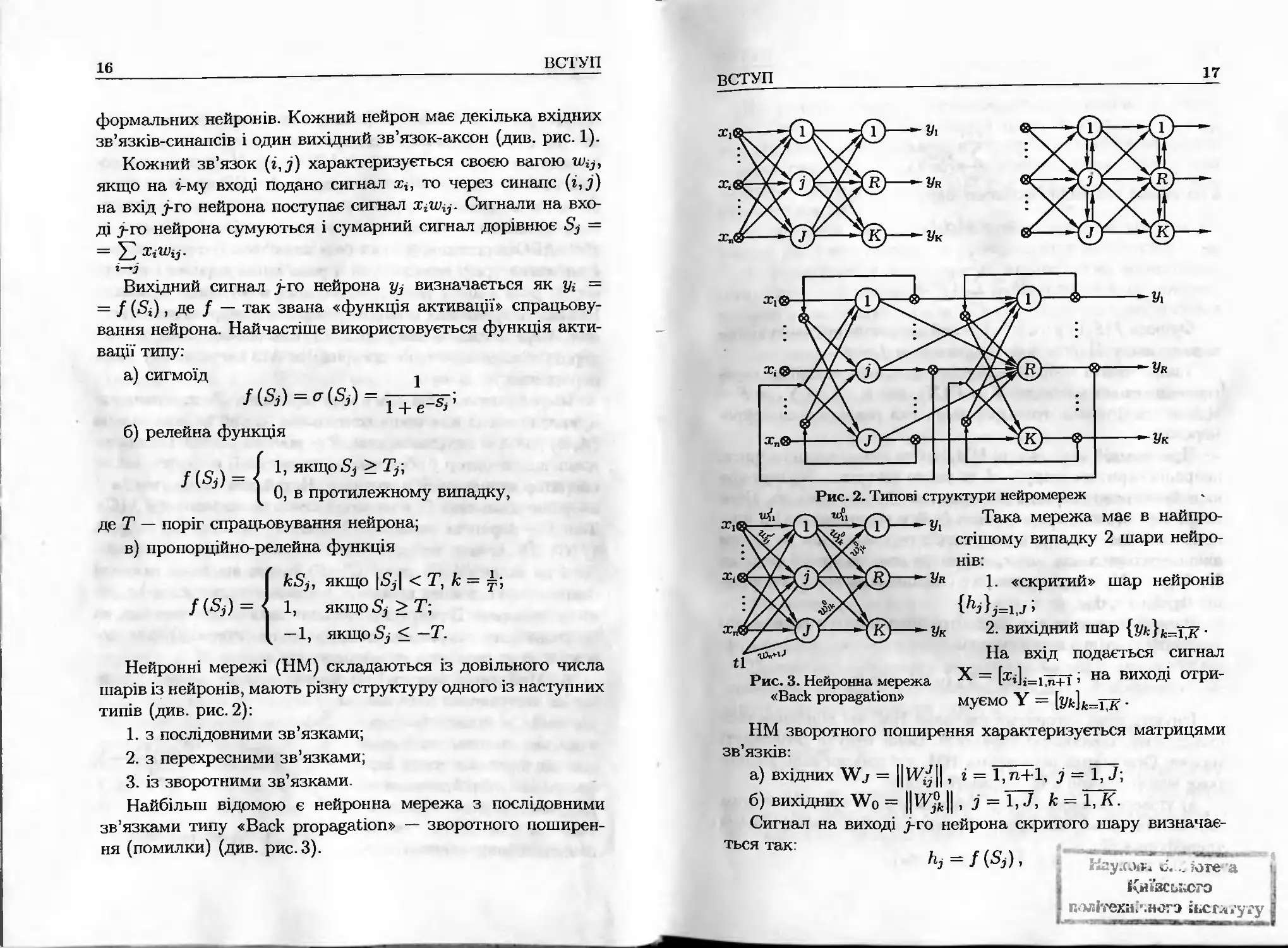

зв’язків-синапсів і один вихідний зв’язок-аксон (див. рис. 1).

Кожний зв’язок (г,7) характеризується своєю вагою

якщо на г-му вході подано сигнал х*, то через синапс (г,у)

на вхід т-го нейрона поступає сигнал ХіН}^. Сигнали на вхо-

ді 7-го нейрона сумуються і сумарний сигнал дорівнює 8у =

= 52 ХіНІгз.

і—І

Вихідний сигнал 7-го нейрона у* визначається як уі =

= / (8г) , де / — так звана «функція активації» спрацьову-

вання нейрона. Найчастіше використовується функція акти-

вації типу:

а) сигмоїд і

/№1=^(5,) = ^^;

б) релейна функція

1, якщо 5^ > Т^\

0, в протилежному випадку,

де Т — поріг спрацьовування нейрона;

в) пропорційно-релейна функція

/ф) = <

кЗ], якщо |5д| < Т, к =

1, якщо5д>Т;

—1, якщо 5^ < — Т.

Нейронні мережі (НМ) складаються із довільного числа

шарів із нейронів, мають різну структуру одного із наступних

типів (див. рис. 2):

1. з послідовними зв’язками;

2. з перехресними зв’язками;

3. із зворотними зв’язками

Найбільш відомою є нейронна мережа з послідовними

зв’язками типу «Васк ргора^аііоп» — зворотного поширен-

ня (помилки) (див. рис.З).

ВСТУП

17

Уі

-®----Ук

Рис. 2. Типові структури нейромереж

Ук

Рис. 3. Нейронна мережа

«Васк ргора^айоп»

Така мережа має в найпро-

стішому випадку 2 шари нейро-

нів:

1. «скритий» шар нейронів

{А}д=і,7 ;

2. вихідний шар {Ук}к=тк •

На вхід подається сигнал

Х = [жі]і=і5ї+Г і на виході отри-

муємо ¥ = [з/*]а.=їтк’ •

НМ зворотного поширення характеризується матрицями

зв’язків-

а) вхідних XV= ЦіУ^Ц , і = 1,п+1, і = 1, 7;

б) вихідних ХУ0 = Ц ІУД Ц , і = ЇГ7, к - Т^К.

Сигнал на виході т-го нейрона скритого шару визначає-

ться так

'>>=/№)•

Київського

і політехнічного ЙіСГл.’угу З

18

ВСТУП

Д6 7і+1

І=1

а на виході нейронів вихідного шару

Ук = 9 (8к),

Де 7

^к = ^З^ук-

Ї=1

Функції / (5?) і д (8к) — функції активації нейронів відпо-

відного шару. Найчастіше приймається / = д.

Таким чином нейронна мережа здійснює нелінійне пере-

творення входів у виходи: V — р (X), або Р : X —» V, де Е —

відповідна функція трансформації, яка реалізується нейро-

мерєжею.

При заданій архітектурі НМ (тобто число входів і число

нейронів скритого шару — та число виходів К) поведін-

ка нейромережі повністю визначається її вагами Шо- Ваги

нейромережі можуть навчатися (тобто Корегуватися) в про-

цесі навчання мережі, коли на вхід подаємо один за одним

вхідні вектори X), х2,..., хп, спостерігаємо на виході сигнали

¥і, ¥2,..., ¥п і порівнюємо їх з бажаними значеннями вихо-

дів

Ваги змінюються так, щоб отримати мінімум середнього

квадрату помилки апроксимації:

71

є2 = V IIй* - ¥* (-)ІІ2 -*тіп-

* IV

Існують різні алгоритми навчання НМ, які відрізняються

складністю, швидкістю збіжності. Вони будуть розглянуті

нижче. Основними перевагами НМ, які забезпечили їм ши-

роке використання в ІС, являються такі:

а) універсальність, тобто нейромережа є «універсальним

апроксиматором», яка здатна реалізувати будь-яку функцію

трансформації: „, .

Р Г(ті,ж2,...,хп).

вступ

19

Ця універсальність підтверджується відповідною теоре-

мою. Для будь-якої неперервної функції /?(хі,х2, - . . ,Хп) ,

яка відповідає ряду досить простих вимог, існує нейронна

мережа типу ВР, що реалізує це відображення з довільною

точністю, тобто IIР (х) - д (х)||2 < є, де д(х) — функція, яка

реалізується НМ.

б) гнучкість, простота навчання нейромереж шляхом на-

вчання ваг з використанням універсальних алгоритмів.

7. Генетичні алгоритми та еволюційне моделюва-

ння. Основний постулат (ідея) еволюційного моделювання

полягає в заміні проблеми побудови моделі складної системи

моделюванням її еволюції.

Еволюційне моделювання базується на трьох основних ме-

ханізмах еволюції живих організмів:

1) схрещування батьківських осіб і генерація нащадків,

2) дія мутацій;

3) селекція, відбір найкращих нащадків.

Процес починається із задання початкової популяції осо-

бин [\¥1 [0] , . . . , IV/У [0]]

Процес еволюційного моделювання — ітераційний про-

цес, на кожній ітерації якого на батьківську популяцію

[\У] [п],..., XV/V [п]] діють послідовно 3 вищевказаних меха-

нізми, в результаті ми отримуємо нову популяцію нащадків

[1У1 [п + 1] , . . . . [п + 1]]

Всі нащадки 'щ [п + 1] оцінюються за деяким критерієм

«пристосовності» РІ (йіпезз іпсіех) і серед них відбираються

/V найкращих, які і утворюють нову популяцію (п+1)-ї ітерації

Процес повторюється багато разів Кожна ітерація тут на-

зивається «епохою». Процес еволюційного моделювання за-

кінчується при виконанні однієї з умов зупинки:

1) Пітер > пзад) де Пітер — ЧИСЛО Ітерацій алгоритму; Ї1зад —

задане число.

2) Р (и\ (п)) > Езвд, де Е,яд — задане значення критерій РІ

На цих же механізмах базуються і численні генетичні

алгоритми оптимізації, які знайшли широке застосування в

комбінаторних задачах оптимізації в ІС.

20

ВСТУП

Зазначимо основні переваги еволюційного моделювання:

а) універсальність, простота реалізації;

б) здатність знаходити глобально оптимальні рішення при

п —» оо.

А основний недолік — високі обчислювальні витрати, які

пов’язані з реалізацією методу, а також наявність деяких па-

раметрів, які необхідно підбирати експериментально, зокре-

ма розмір популяції N.

Розділ 1

ОСНОВИ МАТЕМАТИЧНОЇ ТЕОРІЇ

РОЗПІЗНАВАННЯ ОБРАЗІВ

1.1. Основні етапи розвитку й аналіз сучасного

стану розпізнавання образів

До середини 70-х р.р. розпізнавання як самостійний нау-

ковий напрямок досяг такої стадії розвитку, що з’явилися пе-

редумови створення математичної теорії розпізнавання обра-

зів. Однієї з передумов з’явилася розробка й узагальнення

ряду моделей і алгоритмів розпізнавання образів. До їхнього

числа відносяться [19]:

1. Моделі, засновані на використанні принципу поділу (Я-мо-

делі);

2. Статистичні моделі розпізнавання образів;

3. Моделі, засновані на використанні методу потенційних

функцій;

4. Моделі обчислення оцінок близькості (голосування);

5. Моделі, засновані на обчисленні висловлень.

Дамо їх коротку характеристику.

Моделі, засновані на використанні принципу по-

ділу. Вони розрізняються головним чином завданням класу

поверхонь, серед яких вибирається набір поверхонь, що як

найкраще розділяють елементи різних класів.

Статистичні моделі. Засновані на використанні апарата

статистичної теорії прийняття рішень. Застосовуються в тих

випадках, коли відомі, чи можуть бути визначені імовірнісні

характеристики класів, наприклад, функції розподілу.

Моделі, засновані на методі потенційних функцій

(П-моделі). Базуються на запозиченій з фізики ідеї потенці-

алу, обумовленого для будь-якої точки простору і залежного

22

Розділ 1. Основи математичної теорії розпізнавання образів

від розташування джерела потенціалу. Як функція прина-

лежності об’єкта класу використовується «потенційна функ-

ція» — усюди позитивна і монотонно спадна функція відстані

(Айзерман, Браверман, 1970 р).

Моделі обчислення оцінок близькості (голосуван-

ня) — Г-моделі. Ці моделі засновані на принципі часткової

прецедентності. Аналізується близькість між частинами ра-

ніше класифікованих об’єктів і об’єктів, які необхідно розпі-

знати. Наявність близькості служить частковим прецедентом

і оцінюється за заданим правилом. По набору оцінок близь-

кості виробляється загальна оцінка розпізнавального об’єкта

для класу, що і є значенням функції приналежності об’єкта

класу.

Моделі, засновані на обчисленні висловлень (апа-

раті математичної логіки). Ознаки об’єктів описуються

як логічні перемінні, а опис класів мовою ознак представля-

ється у формі бульових співвідношень (ФАЛ).

1.2. Короткий екскурс в історію

розпізнавання образів

Протягом тривалого часу переважна більшість додатків

теорії розпізнавання образів була зв’язана з погано форма-

лізованими галузями — медициною, геологією, соціологією,

хімією і т.д. Тому на першому етапі розвитку розпізнавання

з’явилася множина методів і алгоритмів, що були застосо-

вані без серйозних теоретичних обґрунтувань для рішення

практичних задач При дослідженні задачі на базі правдо-

подібних міркувань пропонувався нестрогий, але змістовно

розумний метод рішення і заснований на ньому алгоритм, об-

ґрунтування якого проводилося безпосередньо в експеримен-

ті з задачами. Алгоритми, що приносили успіх при рішенні

визначених практичних задач використовувалися надалі, не-

зважаючи на відсутність математичного обґрунтування.

Тому другий етап розвитку теорії розпізнавання образів

відрізнявся прагненням, з одного боку, ставити і вирішувати

1.2. Короткий екскурс в історію розпізнавання образів

23

задачу вибору в конкретній ситуації найкращого алгоритму,

а з іншого боку — переходити від опису окремих некоректних

алгоритмів до опису принципів їхнього формування, тобто

будувати уніфіковані описи для множини евристичних, але

успішно вирішуючих реальні задачі процедур.

Потреба в синтезі моделей алгоритмів розпізнавання

образів визначалася необхідністю фіксувати клас алгоритмів

при виборі оптимальної чи хоча б прийнятної процедури рі-

шення конкретної задачі. У свою чергу побудова таких моде-

лей породила інтерес до власне математичних властивостей

алгоритмів розпізнавання і, особливо, до проблем строгого

обґрунтування.

Перехід до моделей розповсюджених алгоритмів не при-

вів ні до створення універсальної моделі, ні до формалізації

вибору моделі для рішення конкретної задачі розпізнавання

образів, але і він дозволив ставити і вирішувати в рамках

визначеної моделі задачу вибору алгоритму, екстремального

по показниках якості чи класифікації прогнозу. У більшості

практичних випадків клас таких задач невеликий, тому що

в практичних випадках при синтезі моделей алгоритмів роз-

пізнавання образів, описі класів і виборі ознак об’єкта роз-

пізнавання необхідно було б використовувати значний обсяг

апріорної інформації, яку можна одержати лише при наяв-

ності точної моделі досліджуваних об’єктів і явищ.

Надалі, на третьому етапі, був запропонований алгебраїч-

ний підхід до задач розпізнавання образів (ЖуравльовЮ.І.,

1978, 1989р.), що забезпечує ефективне дослідження і кон-

структивний опис проблеми розпізнавання, у тому числі за-

гальне визначення алгоритму розпізнавання образів, у рамки

якого укладаються всі існуючі типи алгоритмів.

В основі алгебраїчного підходу лежить ідея індуктивного

породження математичних об’єктів за допомогою узагальне-

ного індуктивного визначення.

Виділяються базисні алгоритми і моделі розпізнавання

образів і вводяться операції над ними, що дозволяють по-

слідовно породжувати нові моделі.

24

Розділ 1. Основи математичної теорії розпізнавання образів

1.3. Математична постановка задачі

розпізнавання образів

Нехай дана множина М об’єктів {<а}; на цій множині є

розбивка на кінцеве число підмножин (класів) £1к, к = 1,т

ТП

(і.і)

/с=1

Розбивка визначена не цілком — заданий лише деякий на-

бір інформації Іо (Рі, Рг, • • •, Рт) про класи Рд.

Об’єкти задаються значеннями деяких ознак х^, і = 1, N

(цей набір завжди той самий для всіх об’єктів, розглянутих

при рішенні задачі). Сукупність значень ознак визначає

опис об’єкта І(ш) — {хі,Х2, , тлг} .

Варіанти задання значень ознак:

0,

1.

2.

х, - 1,

Д,

якщо ознака не виконується;

якщо ознака виконується;

якщо інформація про ознаку не задана.

Х3 Є {0,1,2,..., й,} — дискретна ознака;

3. X] Є (а, Ь) — інтервал; а, Ь — довільні числа.

Значення ознаки х^ є випадковою величиною з деякою

функцією розподілу Р (х?).

Опис об’єкта І (щ) = {ті (<д), т2 (ш),.. .,х^ (<д)} назива-

ється стандартним, якщо кожний х? (о;) приймає значення

з множини припустимих значень. Задача розпізнавання зі

стандартною інформацією полягає в тому, щоб для дано-

го об’єкта ш і набору класів Рд; А: = 1,т за інформацією

Іо (Рі, Рг, • •, Рт) й описом /(ш) обчислити значення преди-

катів Р Є Р*), к = 1, т.

Інформація про входження об’єкта ш в який-небудь клас

представляється у вигляді так званого інформаційного векто-

1.3- Математична постановка задачі розпізнавання образів

25

ра 7 (о>) = {/і (о>), /2 (о>), - - -, Іт М} , Де Ік (^) несе інформа-

цію про приналежність об’єкта ш до класу £1к

1, си Є

Ік М = * 0, ш <£ Сік',

Д, ЯКЩО невідомо Ш Є Гік або ц} £1к-

Стандартною інформацією Іо (Г2і, Г2г, • - • > &т) називається

сукупність множин виду {/ (<Ді)(<А-„)} і {Л («+0 ,,

...,Іт (ш)} , для яких передбачається, що серед інформацій-

них векторів немає вектора виду (Д, Д,..., Д).

Апріорна інформація в задачі розпізнавання з непересі-

чними класами часто задається у вигляді так званої таблиці

навчання Т^:

Таблиця 1.1.

Таблиця розпізнавання

Об'єкти розпізнавання Ознаки Класи

її Х^ ...

ш. Діл й1.2 . а?3 ... 0,

... ... ... ...

«41 0,2 «4 «4«

«*4 «41 ац.2 °Ч3 °п,<у

«4+11 ач+1-2 ... ап+м ап+іл О2

... ... ...

Шг, «4.1 «4,2 «4Л °т,.П

... ... ...

«*4 ,+і «4„’|+1.1 «4„,_, + 1.2 ^.,+1^ ... «4-іпл

и)Гги «4-і «4-2 «4з аг,„.К

X ь, Ь2 ... ь, ... ь»

2і

26

Розділ 1. Основи математичної теорії розпізнавання образів

1.4. Синтез евристичного алгоритму

розпізнавання образів

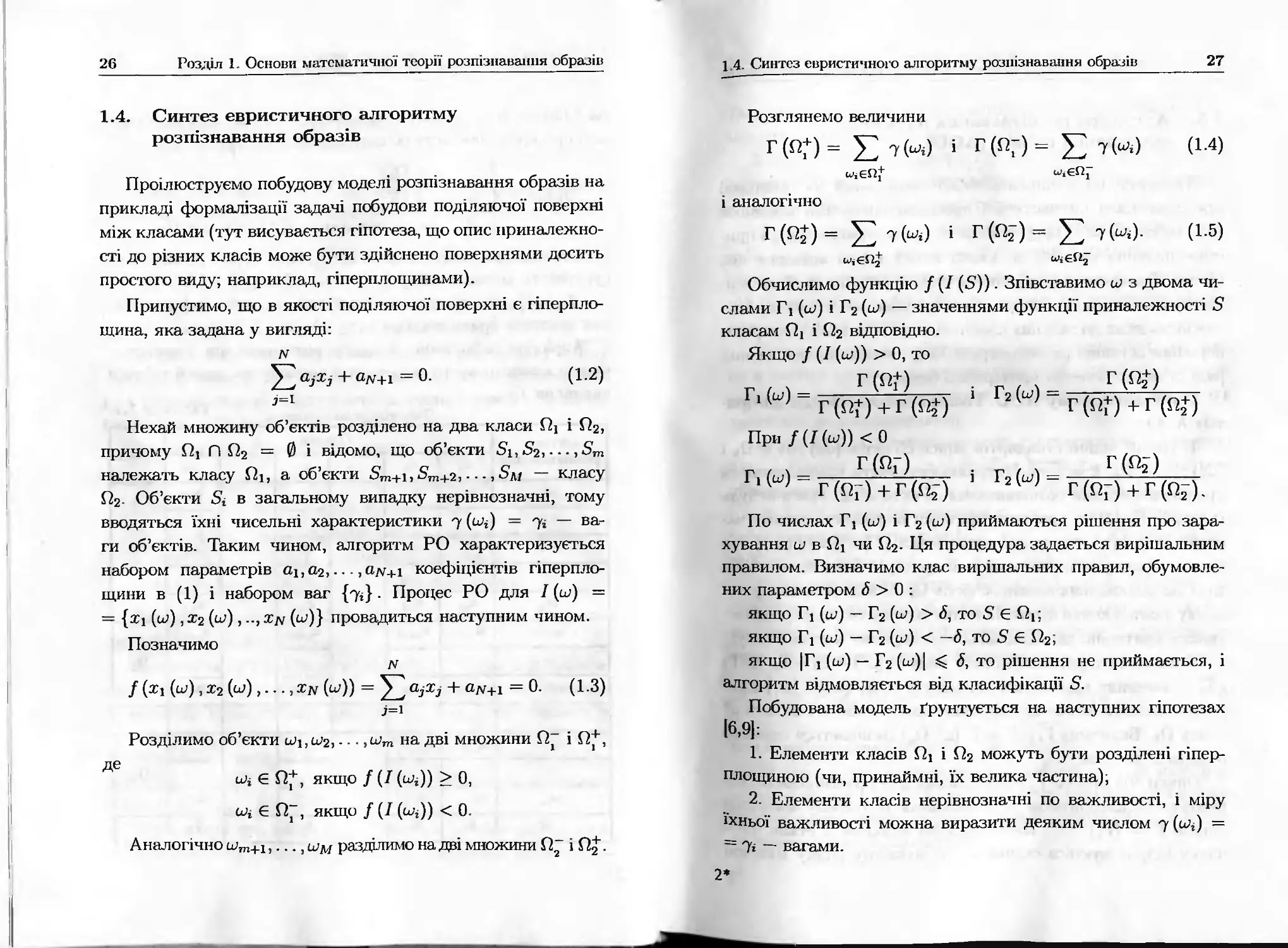

Проілюструємо побудову моделі розпізнавання образів на

прикладі формалізації задачі побудови поділяючої поверхні

між класами (тут висувається гіпотеза, що опис приналежно-

сті до різних класів може бути здійснено поверхнями досить

простого виду; наприклад, гіперплощинами).

Припустимо, що в якості поділяючої поверхні є гіперпло-

щина, яка задана у вигляді:

N

а^Хі + адг+1 = 0. (1.2)

7=1

Нехай множину об’єктів розділено на два класи Пі і П2,

причому Пі Г) П2 = 0 і відомо, що об’єкти 51,52,..., Зт

належать класу Пі, а об’єкти 5то+і, 5т+2,..., — класу

П2. Об’єкти 8і в загальному випадку нерівнозначні, тому

вводяться їхні чисельні характеристики 7 (шг) = 7г — ва-

ги об’єктів. Таким чином, алгоритм РО характеризується

набором параметрів Оі,а2,... , а#+і коефіцієнтів гіперпло-

щини в (1) і набором ваг {7г}- Процес РО для І (ш) =

= {ті (и>) , т2 (а?), ..,Хрі (ш)} провадиться наступним чином.

Позначимо

N

/ (ті (и>), т2 (о;),..., Тдг (а/)) = а7ж7 + а/У+і = 0. (1.3)

7=1

Розділимо об’єкти і^і, ш2,... ,шт на дві множини 0“ і П*,

де

Є П*, якщо / (І (о;,)) > 0,

о>і Є И~, якщо / (/ (о,і)) < 0.

Аналогічно шт+1, .., му разділимо на дві множини і .

1 4. Синтез евристичного алгоритму розпізнавання образів

27

Розглянемо величини

Г(П*) = Е іМ і Г(Я-)= £ 7(и,.) (1.4)

і аналогічно

Г(^) = Е і Г(Я2-)= Е (1-5)

Обчислимо функцію / (/ (5)). Зпівставимо о? з двома чи-

слами Гі (ш) і Г2 (ш) — значеннями функції приналежності З

класам і П2 відповідно.

Якщо / (/ (ш)) > 0, то

Г(ПП . х Г(П^)

Г|Н= г(п+)+г(О 1 Г2И = г(п+)+г(п+)

При /(І(ш)) <0

Г(ПГ) : Г / Ч _ Г )

1Н г(пГ)+г(02-) 2(ш) Г(пг) + Г(п2).

По числах Гі (ш) і Г2 (ш) приймаються рішення про зара-

хування ш в Пі чи П2. Ця процедура задається вирішальним

правилом. Визначимо клас вирішальних правил, обумовле-

них параметром <5 > 0 :

якщо Гі (ш) — Г2 (ш) > <5, то 8 є Пі;

якщо ?! (ш) — Г2 (ш) < —6, то 8 Є П2;

якщо |Гі (ш) — Г2 (ш)| <5, то рішення не приймається, і

алгоритм відмовляється від класифікації 8.

Побудована модель ґрунтується на наступних гіпотезах

[6,91:

1. Елементи класів Пі і П2 можуть бути розділені гіпер-

площиною (чи, принаймні, їх велика частина),

2. Елементи класів нерівнозначні по важливості, і міру

їхньої важливості можна виразити деяким числом 7 (шЦ =

= 7і — вагами.

2*

28

Розділ 1. Основи математичної теорії розпізнавання образів

1.5. Алгоритм розпізнавання на основі

обчислення оцінок (АОО)

Алгоритм розпізнавання АОО заснований на принципі

прецедентності чи часткової прецедентності. Він порівнює

опис об’єкта І (о/), що розпізнається, з матрицею Т^<т і при-

ймає рішення про те, до якого класу варто віднести цей

об’єкт. При цьому рішення виноситься в результаті обчислен-

ня ступеня подібності цього об’єкта з тими об’єктами, прина-

лежність яких до заданих класів відома. Для цього алгоритм

порівнює останній рядок матриці Т^-тп з кожним з попередніх

рядків за визначеним критерієм близькості.

Опис алгоритму АОО. Розглянемо основні ідеї алгори-

тму АОО.

1. Нехай задані стандартні описи об’єктів {иД , € Пд і

{й1,}, шг Пд, к — 1,т. Потрібно визначити приналежність

пред’явленого для розпізнавання об’єкта о/ до якого-небудь

із класів Пд. Якщо введено критерій близькості деяких ча-

стин опису І (о/) до відповідних частин {7 (с<л)} і {/ (оЦ}, то

можна сформувати узагальнений критерій близькості об’єк-

та ш' до відповідних класів об’єктів О*.. У найпростішому ви-

падку узагальнений критерій визначають у вигляді суми час-

ткових критеріїв, що відносяться до окремих частин опису.

У результаті, характеристику виду Г, (о/) = Г, — Гг, де Гг

і Г, — значення відповідної близькості о/ др {о/,} і {й),} при-

родно вважати значенням функції приналежності об’єкта ш'

класу Пк- Величина Гг (о/) = Гг (ц/, £ік) називається оцінкою

об’єкта а)' по класу Пд.

Описи об’єктів {а/} , пред’явлених для розпізнавання, пе-

реводяться алгоритмом розпізнавання в числову матрицю

оцінок Г = {Г,}Мхгп. Ця процедура включає 2 етапи- спо-

чатку підраховується оцінка ш' по кожному рядку магриці

1.5. Алгоритм розпізнавання на основі обчислення оцінок

29

Тдг.т, а потім ці оцінки використовуються для одержання су-

марних оцінок по кожному з класів Пк.

2. Розглянемо процедуру побудови оцінок Г, (о/), вико-

ристовувану в тестових алгоритмах АОО. В основі тестових

алгоритмів лежить поняття «теста».

Тестом матриці Т^т називається сукупність таких стов-

пців тгі,т(2,... ,х1д, що після видалення з матриці Т^<тп всіх

стовпців за винятком зазначених х31,х]2,... ,Хдч, в отрима-

ній матриці Тдг-9,тп будь-які два рядки, що належать різним

класам, будуть різні.

Тест називається тупиковим, якщо ніяка його частина

не є тестом (тобто тупиковий тест — це такий тест, що не

можна видалити з нього жодного стовпця (ознаки) без втрати

здатності до розпізнавання).

Нехай {Ттеуп} — множини усіх тупикових тестів матриці

Тіу.т І Т — (х1і,хі2,...,х1ч') Є {Ттуп} . ВИДІЛИМО В ОПИСІ рОЗ-

пізнаваного об’єкта І (у/) = (Ьі,..частину [Ьі}, ЬІ2, ч..,

..., Ьід} , що відповідає ознакам хг,, хІ2,..., хід і зіставимо її з

усіма частковими описами ,аіід} об’єктів матри-

ці 7дгіТО, де і = гк_і + 1... гк, к = 1, т (г0 = 0).

Підрахуємо число збігів — Гу (о/, П*.), що являє собою чи-

сло рядків цього класу, близьких до розпізнаваного рядка

по тесту Т. Аналогічно обчислюється оцінка иУ по інших те-

стах (для кожного класу). Величина

Г(^,П,) = —----------V гт(^,^) (1-6)

Г*. — Гь-1 *—у

* к 1 тє{7„.и„}

являє собою оцінку об’єкта ш' по класу $їк.

Відомі різновиди тестових алгоритмів, у яких при фор-

муванні оцінок Гу (ц/, П*.) враховуються розходження в пока-

зниках «важливості» окремих рядків матриці Т^<т й ознак,

включених у стандартні описи.

22

зо

Розділ 1. Основи математичної теорії розпізнавання образів

(1.7)

Для цього використовуються числові коефіцієнти — ваги

ознак і ваги об’єктів. Найчастіше ці ваги задаються за допо-

могою експертних оцінок.

Для тестових алгоритмів була запропонована наступна мі-

ра важливості ознак — «інформаційна вага» (Дмитрієв):

1 11 г(ІЧ.т) ’

де г (IV, т) — загальне число тупикових тестів матриці 7\,то;

гХі (IV, т) — число тупикових тестів матриці Тк,т, що містять

ознаку X].

Якщо враховуються ваги ознак Р (37), Р (х?),..., Р (х^)

і ваги об’єктів матриці — 7 (шД ,7 (шг),... ,7 (шг), то

кожен збіг часткового опису {Ь41, ЬІ2,..., об’єкта з час-

тковими описами {ац1,аіІ2,...,ацч} об’єктів з що від-

повідає деякому тесту Т, оцінюємо величиною

Гт (иУ, шД = 7 (шД • (Р (тгД + Р (хІ2) + ... + Р (хгД) . (1.8)

У результаті оцінка об’єкта по класу П*. приймає насту-

пний вигляд:

Г(ш'А) = 1 У £ Гт(иЛ«,)

Тє{Ттуп} з=гк_1+1

(1.9)

Перехід від тестових алгоритмів до АОО зв’язаний з роз-

ширенням видів підмножин множини ознак, за якими прово-

диться зіставлення невідомого об’єкта з об’єктами з і

побудовою ефективної формули обчислення оцінок Г (иУ, ПД

для різних випадків завдання підмножин множини ознак (в

АОО вони називаються «опорними множинами» алгоритму

розпізнавання). У тестових алгоритмах як опорні множини

використовуються множини тупикових тестів.

В АОО розглядаються два випадки визначення опорних

множин:

1.5. Алгоритм розпізнавання на основі обчислення оцінок

31

1. Наявність обмежень на систему опорних множин алго-

ритму.

2. Відсутність обмежень на систему опорних множин ал-

горитму.

У першому випадку найбільш розповсюдженими є систе-

ми опорних множин, складених із усіх підмножин множини

ознак заданої довжини д, д = 2,..., N — 1.

Розглянемо повний набір ознак {а?і,х2,... ,Ждг} і виді-

лимо систему підмножин множини ознак (систему опорних

множин алгоритму) Хі, х2,..., %к- Видалимо довільний набір

ознак з рядків ... ,<х>Гтп,ш' і позначимо отримані рядки

через 5ш2, ..., 8шГт, 8иУ.

Критерій близькості дозволяє оцінити подібність рядків

8ш, і 8ш'. Він полягає ось у чому. Нехай усічені рядки мі-

стять д перших ознак, тобто 8ші = {щі, аі2,..., а^} і 5ш' =

— {^і, Ь2,..., . Тоді рядки 8ші і 8ш' вважаються схожими,

якщо виконується не менше, ніж 6 нерівностей виду:

Іаі - Ьі\ < 7 = М- (1-Ю)

Величини £і,£2, ... ,£д, 6 входять як параметри в модель

класу алгоритмів типу АОО. (Звичайно £і = £2 = ... = = £).

Розглянемо процес обчислення оцінок по підмножині 51.

Для інших підмножин вона аналогічна. У матриці виді-

ляються стовпці, що відповідають ознакам, що входять у 5і

(інші стовпці викидаються). Перевіряється близькість рядка

8\іУ з рядками 51^, і = 1,г,, а отже, і приналежність до

класу П! (за критерієм (1.10)).

Число рядків цього класу, близьких до класифіковано-

го рядка 5іш' за обраним критерієм (1.10), позначимо через

(ш', П(). Аналогічно обчислюються оцінки для всіх інших

класів:

2**

32

Розділ 1. Основи математичної теорії розпізнавання образів

Ці операції проводяться для всіх опорних множин 51,...,

... ,8п і для кожної з них обчислюють відповідні оцінки

близькості:

Г51 (ц/,£21),...,Г5<,(ц/,£2„1),

ц = ІЛ-

Величини

Г$Л (ь/, £2*.) = Г51 (о/, £2*) + Г$2 (а/, £2*) + ...

ч (1 121

... + Г5Д^,£2Ц = ^Г5Да/.£2,) ’

11=1

являють собою оцінки рядка а/ для відповідних класів по

системі опорних множин алгоритму 8д. На підставі аналізу

цих величин приймається рішення або про віднесення об’єкта

иУ до одного з класів £2^, к — 1,т, або про відмовлення від

розпізнавання.

Вирішальне правило може приймати різні форми:

1. Або розпізнаваний рядок відноситься до класу з макси-

мальною оцінкою;

2. Або ця оцінка буде перевищувати оцінки для всіх інших

класів не менше, ніж на визначену граничну величину т?і;

3. Або величина відношення відповідної оцінки до суми

оцінок для всіх інших класів не менш деякого порога %•

Визначення класу АОО зводиться до формалізації насту-

пних етапів процедури розпізнавання:

1. Виділяється система опорних множин алгоритму, за

якими провадиться аналіз розпізнаваних об’єктів;

2. Уводиться міра близькості на множині часткових описів

об’єктів;

3. Задаються правила:

а) правило обчислення оцінки для пар об’єктів за значен-

ням ступеня подоби еталонного і розпізнаваного об’єктів;

б) правило формування оцінок по фіксованій опорній мно-

жині для кожного з еталонних класів на основі оцінок для

пар об’єктів;

1.5. Алгоритм розпізнавання па основі обчислення оцінок

33

в) правило формування сумарної оцінки для кожного з

еталонних класів по всіх опорних множинах;

г) правило прийняття рішень на основі сумарних оцінок,

що забезпечують віднесення невідомого об’єкта до одного з

класів чи відмовлення від класифікації даного об’єкта.

Якщо будувати обчислювальну процедуру за приведеним

описом алгоритму, то при великій кількості опорних множин

потрібен значний обсяг обчислень. Так при виборі як системи

опорних множин усіх підмножин множини ознак потужно-

сті д число опорних множин дорівнює С1^, а число додан-

ків у формулі, що визначає величину , дорівнює

(Л - Гі_і) • С^.

Відомі два методи, комбінація яких дозволяє одержати

прості формули для практично важливих моделей АОО (за

умови, що використовуються граничні функції близькості,

що приймають значення 0 і 1) і Р (5) = Р (х41) 4- Р (хІ2) +...

(тд) (вага опорної множини дорівнює сумі ваг вхідних

у нього ознак).

Перший метод, запропонований Журавльовим (1978) [6],

використовує властивість оцінок для класифікації по опорній

множині 8У, V = 1, т.

Тут використовується оцінка виду

Г (о/, П*.) =--—--х

Ті - Д_і

х У? 7 (^і) + Ріг + • - + Рі.д) В8„ (ш, ші) ,

де її,..., — сукупність номерів ознак, що визначають опор-

ну множину В8гі — функція близькості часткових описів

об’єктів Зуїд' і 8уи,. що приймає значення 1 чи 0, у залежності

від числа виконаних нерівностей виду

І«ї “У < & З = ЇЇ9-

2і

34

Розділ 1. Основи математичної теорії розпізнавання образів

1.6. Метод розпізнавання образів на основі

статистичної теорії прийняття рішень

Нехай маємо К класів: 14, к — І.К. Позначимо: Р (X |14)

— імовірність того, що X належить к-му класу (умовна щіль-

ність зображення); рк— апріорна імовірність появи зображен-

ня к-го класу; X— зображення, що спостерігаються (об’єкти).

Спостерігаємо Х3. Необхідно визначити приналежність

його до якогось класу. Для цього обчислюється [3]

рґсіхї Р(Х3\УкуРк _ Р(Х3\Ук)-Рк

р \Ук |лу) =--——---------- —-------------, (113)

1 £Р(ХДИ)-Рг

І=1

(1.13) — функція правдоподібності. Далі приймається рішення:

Х3 Є Ук, якщо Р(Х3\Ук)-рк = тахР(ХДЦ)-А (1.14)

і=1,К

(на основі принципу максимуму правдоподібності)

Недолік: звичайно невідомі Р (X 114 ), відомий лише клас

законів розподілу імовірностей (сімейство законів з різними

параметрами)

р(х,К) = х(^,^), к = ТУк.

Нехай тк — ризик, зв’язаний з помилковою класифікацією

об’єктів розпізнавання, що належать класу Ук (тобто ситуа-

ція, коли об’єкт із 14 помилково віднесли до іншого класу).

Позначимо Імовірність ПОМИЛКИ Р,мм (Ук).

Середній ризик розпізнавання [3,19]

к

к=1

Середня помилка розпізнавання к-го класу визначається

в такий спосіб

РпОМ(Ук)= У Р(Х\Ук)<іх. (1.15)

ХєУк

1.6. Метод розпізнавання образів на основі статистичної теорії ... 35

Необхідно знайти вирішальне правило О (X, 14), при яко-

му \У —> шіп .

О(Х.П)

Для одномірного закону розподілу (X — скаляр) із умови

Р (X |У]) = Р (X |І4) знаходимо значення величини (І*. Далі

приймається рішення

Хп Є Ц, якщо Хп < (Г;

Хп Е У?, якщо Хп > (1*.

Якщо Гі Гг . 7^ гк, то границя буде визначатися з

урахуванням ваг

В (X, 14) : Хп Е Ук, якщо гк Р (Х„ |І4) = тах.

к

Нехай Гі > гк, тоді сГ визначається з виразу:

гі-Р(Х\Уі) = гк-Р(Х\Ук). (1.16)

Якщо попадаємо в точку, в якій виконується рівність

(1.16), то відмовлення від ухвалення рішення

Цей підхід широко застосовувався в 70-і роки для розпі-

знавання радіолокаційних сигналів.

Сфера застосування теорії статистичних рішень при роз-

пізнаванні образів обмежена тим, що її методи припуска-

ють відомими умовні щільності імовірності. При вирішенні

практичних задач точне чисельне значення цих імовірностей

одержати дуже складно. Однак принципово завжди можна

одержати наближене значення щільності розподілу імовірно-

стей, визначивши відносну частоту, з якою з’являється кожне

зображення. На практиці обмежуються скінченним і порівня-

но малим числом зображень, за якими оцінюються невідомі

розподіли.

Відповідно до теорії статистичних рішень, навчання мо-

жна розглядати як знаходження або приблизну оцінку щіль-

ностей розподілу імовірностей у просторі описів.

У процесі розпізнавання оцінюються і зіставляються отри-

мані умовні щільності імовірностей кожного образу для тієї

точки векторного простору, що відповідає досліджуваному

2**«

36

Розділ 1. Основи математичної теорії розпізнавання образів

зображенню. При навчанні передбачається, що зображен-

ня навчальної послідовності досить повно представляють

розглянуті образи. Цс припущення дозволяє допустити, що

щільності імовірностей, побудовані по навчальній послідов-

ності, близькі до істинних.

Істотним обмеженням методів теорії статистичних рішень

є складність практичної реалізації. Якщо щільності імовір-

ностей не вдається представити аналітично, то, навіть якщо

вони відомі, необхідно зберігати в пам’яті їхні значення для

кожної точки п-мірного простору. Обсяг необхідної пам’яті

при цьому такий великий, що побудова машин, що розпізна-

ють, заснованих на обчисленні коефіцієнта правдоподібності,

практично неможлива. Тому часто передбачається, що хара-

ктер розподілів відомий (наприклад, нормальний розподіл),

але невідомі його параметри (наприклад, математичне споді-

вання, дисперсія), тобто закони розподілу задаються з точні-

стю до параметрів. У цьому випадку задача навчання істотно

спрощується і складається лише у визначенні невідомих па-

раметрів. Часто прагнуть сформулювати такі правила, що

були б прості в реалізації, але по надійності наближалися до

методу, заснованому на статистичних рішеннях, тобто до ме-

тоду коефіцієнтів правдоподібності.

Рішення, отримані згідно баєсовському правилу при пев-

ному правилі апроксимації щільності імовірності, збігаються

з рішеннями, отриманими на підставі порівняння евклідових

відстаней між зображеннями в перетвореному просторі.

1.7. Метод потенційних функцій

У роботах М. Айзермана, Е. Бравермана, Л. Розоноера в

журналі «Автоматика і телемеханіка» («АіТ» 1964, №6, 9, 12;

«АіТ» №11, 1965; а також АйзерманМ.А., БравсрманЕ.М.,

РозоносрЛ.І. Проблема навчання машин розпізнаванню зов-

нішніх ситуацій — У зб.: Автоматичні системи, що самонавча-

1 7 Метод потенційних функцій

37

ються Наука, 1966) були розроблені і досліджені алгоритми

розпізнавання, в основу яких покладені так звані потенцій-

ні функції. Запропоновані авторами алгоритми базуються на

основній гіпотезі про характер функцій, ідо розділяють мно-

жини, які відповідають різним образам [1].

1.7.1. Геометрична інтерпретація методу

Для спрощення, але без обмеження спільності, розгляне-

мо задачу РО для двох класів Ц, У2-

Будемо вважати, що в просторі вхідних описів кожному

вхідному зображенню 8 (х) відповідає єдина точка простору

X. Припустимо, що класи Ц і 14 не перетинаються. Це озна-

чає, що в просторі вхідних описів X існує, принаймні, одна

функція, яка цілком розділяє множини зображень, що нале-

жать різним образам. Ця функція Ф (х) повинна приймати

значення Ф (х) > 0 в точках, що відповідають зображенням

образа Ц і Ф (х) < 0 для х Є Ц. У загальному випадку таких

поділяючих функцій може бути багато. У процесі навчання

системі, що розпізнає, послідовно пред’являють зображення,

яким відповідають точки простору X. При цьому відомо, до

якого класу Ц чи 14 належать показані зображення. Метод

потенційних функцій зв’язаний з наступною процедурою.

При показі (пред’явленні) у ході навчання деякого зображе-

ння 8к (ж), якому відповідає точка Хк в просторі X, з ним

зв’язується функція V (х, Хк), задана на всьому просторі X і

залежна від Хк як від параметра. Така функція називається

потенційною. Навчальній послідовності 8 = {51,8?,.... 5д.} і

точкам X], х2,. .,х*. простору X відповідає послідовність по-

тенційних функцій V (х, хі), [7 (х, х2),...,[/ (х, х*,), що вико-

ристовується для побудови поділяючої функції Ф (х) за допо-

могою визначальних правил. Правила формування функцій

повинні бути такими, щоб у міру збільшення числа пред’яв-

лених зображень функція Ф (х) наближалася б до однієї з

поділяючих функцій.

38

Розділ 1 Основи математичної теорії розпізнавання образів

Метод потенційних функцій припускає існування в про-

сторі X системи функцій (х) ,1 = 1,2,..., що дозволяють

для кожної пари поділяючих множин знайти такс X, при яко-

му поділяючу функцію можна було б представити у вигляді:

N

Ф(х) = 22сі<а(х). (117)

ї=і

Якщо в просторі X існує повна система функцій, то (х)

можна вважати її елементами і будь-яка функція цієї системи

може бути представлена у вигляді нескінченного ряду

оо

ф(х)= 52с«^(х). (і-і8)

г=і

Однак нам бажано, щоб поділяюча функція (згідно (1-17))

розкладалася в ряд із скінченним числом членів N 3 цього

випливає, що поділяючі функції в просторі X повинні бути

досить гладкими і не мати великого числа екстремумів у ма-

лій області. Використовуючи (1.17) можна ввести в розгляд

//-мірний простір 2, на який відображається вихідний про-

стір X. Кожній точці простору X ставиться у відповідність

точка простору 2 відповідно до співвідношення 2г — <рг (х),

і = \Х.

Внаслідок умови (1.17) поділяюча функція Ф (х) відобра-

N

жається в лінійну функцію 52 аг^і (х) в просторі 2 і має на-

і=1

ступну властивість:

N

Ф (х) = Сі2і (х) > 0, якщо х Є Ц;

(119)

Ф (х) — Сі2і (х) < 0, якщо х Є У2.

І=1

У зв’язку з тим, що функції, що розкладаються по систе-

мі (х), лінсаризуються в просторі 2, останній називають

спрямляючим простором.

1.7. Метод потенційних функцій

39

1.7.2. Алгоритм розпізнавання, заснований

на методі потенційних функцій

В якості потенційної функції приймається скалярна фун-

кція двох векторних аргументів вигляду

оо

Ф (х) = ^2 «г • <Рі (х) • (Х*)> (12°)

і=1

де ірі (х) — лінійно-незалежна система функцій: — дійсні

числа, відмінні від 0 для всіх і, я* — точка, що з’являється в

ході навчання.

Передбачається, що <рг (х) й І/ (х, х*) обмежені для х Є

Є Ц О Ц. Нехай у процесі навчання пред’являються зобра-

ження 5і, 52,.. , Зк, яким відповідають точки хь х2,..., хй в

просторі X. Кожна з точок належить Уі чи Ц. Будемо вва-

жати множину Ц позитивною, а У2 — негативною. З появою

першої точки хі будується потенційна функція Пі (х), рівна

потенціалу, що відповідає точці хі, який береться з відповід-

ним знаком:

С7,(х) = ] С7<Х’Х,)' якио ХЄІ‘; (1.21)

—V (х, хі), якщо х Є У2.

Далі нехай після г-го пред’явлення побудовано потенціал

ПДх).

На наступному (г +1) -му кроці навчання показується то-

чка Хі+1 . У результаті можливі 4 випадки:

1. Хі+і Є И;С7і(хі+1) > 0;

2. Хі+і Є У2; 1/і (хі+і) < 0;

3. х.+1 є Уі;Ді(хі+і) < 0;

4 Хі+і є Ді (х»+і) > 0.

У випадках 1 і 2 алгоритм правильно класифікує зобра-

ження 5і+і. У цьому випадку приймається

Пі+1 (х) = Уі (х). (1.23)

40

Роїділ 1. Основи математичної теорії розпізнавання образів

У 3 і 4 випадках є помилка класифікації і необхідна коре-

кція потенційної функції.

Для випадку 3 приймаємо

Пі+І (х) = Ні (х) + Д(х,Хі+1). (1.24)

Для випадку 4 приймаємо

ї/і+1 (х) = 1/і (х) - П (х, хі+1). (1.25)

Побудований після г-го кроку потенціал можна записати

в такий спосіб:

^і(х) = У2 П(х,хк)- £2 ^(х>х<?), (1-26)

Х*.(_)ЄЦ Х,(_)ЄР2

де хд;(_) — точки, що належать образу Ц, підстановка яких

у попередній потенціал приводила до помилки класифікації;

аналогічно х9(_), точки, що належать образу Ц, які були по-

милково класифіковані.

У роботах авторів було розроблено кілька алгоритмів РО,

заснованих на методі потенційних функцій [1,3].

Розходження між варіантами алгоритму зводиться в

основному до вибору законів корекції поділяючої функції від

кроку до кроку.

Перший алгоритм. Будемо вважати, що побудовано

функцію Фі (х), а на (г + 1)-му кроці пред’явлена т. х,+1,

для якої відомо дійсне (необхідне) значення функції Ф (хг+і).

Воно повідомляється вчителем. Тоді функція Фі+1 (х) будує-

ться за наступним правилом:

Фі+і (х) = Ф, (х) + аг+і-

(1.27)

[єщп Ф (Хі+і) - ЄЩП Фг (Хі+1)] 17 (X, Хі+1) ,

де Ф(хг+і) — дійсне значення поділяючої функції в т Хі+і;

аг+і — будь-яка послідовність чисел, що задовольняє наступ-

1.7. Метод потенційних функцій

41

ним умовам:

00 00

а’—* о, 52а»= °°> 52< °°-

і=1 »=1

Наприклад, а, = с)і,с = сопзі.

Збіжність алгоритму обґрунтовується наступною теоре-

мою, доведення якої див. [Айзерман М.А., Браверман Е.М.,

Метод потенційних функцій у задачі відновлення характери-

стики функціонального перетворювача по струмах, що ви-

падково спостерігаються], [« АіТ», № 12,1964].

ТЕОРЕМА 1. Нехай х, — послідовність незалежних ви-

падкових точок з X, а Р(хг) — послідовність імовірностей

їхньої появи.

Нехай Ф (х) — функція, що задовольняє умові (1.17)

N

ф(х) = 52Сі,рі

г=1

Тоді послідовність функцій Ф,(х) (г = 1,2,...), що визна-

чаються рекурентним співвідношенням (1.27) при і —> оо за-

довольняє умові:

Р < Іііп [ |Ф(х) — Фг(х)| • Р(х)(1х = 0 > = 1. (1-28)

(і-ооУ )

Другий алгоритм. Як і раніше, покладемо Фо(х) = 0.

фі+і (х) = Фі (х) + у • [Ф (хі+і) - Фі(хі+і)]-Р (х,хі+і), (1.29)

де Л — довільна позитивна константа, що задовольняє умові

Л = - шах (7 (х,х‘), (1.30)

де Ф (хі+і) — дійсне значення поділяючої функції на т. хі+і.

Збіжність цього алгоритму підтверджується наступною

теоремою.

42

Розділ 1. Основи математичної теорії розпізнавання образів

ТЕОРЕМА 2. Нехай виконуються ті ж умови, що й у

теоремі 1. Тоді послідовність функцій Фі (х) (і = 1,2,...),

які визначаються рекурентним співвідношенням (129) при

і —> оо задовольняє умові

Р< ,1пп / |Ф(х) - Фі (х)|2 • Р(х)гіх = 0 > = 1.

(1-31)

Наведені алгоритми можна використовувати і для послі-

довних наближень коефіцієнтів с7 у представленні поділяю-

чої функції ЛГ

ф (х) = 52 (х)

і=і

за формулами

N

8І§П Ф (хі+1) - 5І£П ^2 С^і (Хі+1)

і=1

-¥>і(хі+і), (1.32)

з =

N

ф(хі+о - 52

І=1

(хі+і) >

(1.33)

Дані алгоритми є алгоритмами статистичної оптимізацїї,

окремими випадками методу СКГ. Описаним алгоритмам мо-

жна дати зручну геометричну інтерпретацію, використовую-

чи для цього процес навчання. Будемо вважати, що в просто-

рі X існує поділяюча поверхня Ф (х), яка може бути пред-

ставлена розкладанням (117), причому така, що виконую-

ться умови (1.19). Тоді в спрямляючому просторі існує поді-

ляюча площина з направляючим вектором V, що проходить

1.7. Метод потенційних функцій

43

через початок координат:

оо

така, що

якщо х Є Ц;

якщо х Є 14;

(1.34)

Відобразивши множину У2 симе-

трично відносно початку координат,

одержимо множину V — Ц О У2, Де

У2* — відображення множини У2 (див.

рис. 1.1). Множини Уі і У2 можуть

бути розділені площиною з направ-

ляючим вектором V (Ут2 = 0) за

УМОВИ, ЩО оо

Vу 2 = Уі2і > 0, при

Рис. 1.1. Побудова

множини У2’

2 Є V.

Іншими словами множини Ц і 14 розділяються цією пло-

щиною за умови, що об’єднана область V лежить по один

бік від неї. Поставимо у відповідність послідовність М точок

{хі,х2,... ,хр} із простору X, що належать множинам Ц і

У2, І ПОСЛІДОВНІСТЬ М ТОЧОК {2і,22, - -. , 2р} з У = Уі О У2.

Потенційна функція може бути представлена в спрямляючо-

му просторі 7 як скалярний добуток двох векторів 2,2*, де

7г — аг^г (х) і 7* — ацр.(х*). (1.35)

Тоді вирази (1.20) для потенційної функції можна пред-

ставити в наступному вигляді:

Щх,х‘) = 2-2*. (1.36)

Тепер вирази (126) можна переписати так:

Пр(2)= £ 2 2д,

2,_єМ*

(1.37)

44

Розділ 1 Основи математичної теорії розпізнавання образів

де 2д_ — точки з послідовності М*, пред’явлення яких у про-

цесі навчання призвело до виправлення помилок.

Якщо з послідовності точок М* вилучити всі точки, що

не призвели до виправлення помилок, а точки, що залиши-

лися, (необхідні для виправлення помилок) перенумерувати

підряд, то вираз (1-37) можна переписати в такий спосіб:

*:(Р)

Пр(2) = 2 • У 2т, 2т є М*‘, (1.38)

771—1

де М** — множина точок, що включають у себе тільки ті то-

чки, які супроводжувалися виправленням помилок, що від-

булися протягом перших р пред’явлень

Виправлення помилки в точці 2 Є V буде відбуватися за

умови 1/р (2) < 0.

На підставі цього можна стверджувати, що (к + 1)-е ви-

правлення помилки відбудеться, якщо

к

2а.+і 52 2т < 0. (1.39)

771=1

Тепер роботу алгоритму можна пояснити в такий спосіб.

Поява першої точки 2] з множини М* приводить до побудови

в спрямляючому просторі площини Пі (2) = (2, 2і) = 0 з на-

правляючим вектором 2]. У випадку, якщо наступна точка з

М* лежить у тому ж підпросторі (просторі), куди орієнтова-

ний направляючий вектор 2г, то помилка буде відсутня і при

цьому положення ПОДІЛЯЮЧОЇ ПЛОЩИНИ І вектор 21 не зміню-

ються, і провадиться пред’явлення наступного зображення.

Як тільки пропонована точка потрапить у протилежний пів-

простір, відбувається виправлення помилки.

При цьому направляючий вектор площини V, побудова-

ний до цього кроку, складається з вектором точки, яка

потребувала виправлення, і сумарний вектор приймається

за новий направляючий вектор (див. рис. 1.2, де показаний

1.7. Мегод потенційних функцій

45

випадок, коли виправлення

помилки було вже потрібно

на 2-му кроці. Тут новий

направляючий вектор дорів-

нює 2і + 22). У загальному

випадку, після к виправлень

помилок направляючий век-

тор поділяючої площини

Рис. 1.2. Випадок, коли виправлення

помилки вже потрібно на 2-му кроці

дорівнює

к

^2 (ДЄ 2т Є М*) .

т=1

(1-40)

Після певного числа пред’явлень зображень з навчальної

послідовності одержимо площину, що проходить через поча-

ток координат спрямляючого простору, яка приймається за

поділяючу площину. На цьому навчання закінчується. У про-

цесі розпізнавання для кожної нової точки підраховується

значення С/ (ж), а рішення приймається за знаком /7 (х).

1.7.3. Збіжність алгоритму потенційних функцій

і умова його зупинки

У [1] доведено 2 теореми, в яких стверджуються дуже ва-

жливі властивості алгоритмів, заснованих на методі потен-

ційних функцій. Перша з них стверджує, що число виправ-

лень помилок в алгоритмах скінченне, а в другій доводиться

збіжність цих алгоритмів.

ТЕОРЕМА 3. Нехай М — довільна нескінченна послі-

довність точок {хі, х2,..., хр} простору X, що належать мно-

жинам Ц і Ц. Припустимо, що існує функція Ф (х) така, що

ґ > £, якщо х Є V];

Ф(х) = ч 4 1.41)

[ < — £, якщо х є Ц.

Крім того, ця функція може бути представлена розклада-

нням (1-17). Нехай /7 (х,х*) обмежена на Ц СІ У2. Тоді існує

46

Розділ 1. Основи математичної теорії розпізнавання образів

ціле число А:, що не залежить від вибору послідовності Л/, та-

ке, що при використанні методу потенційних функцій число

виправлень помилок не перевершує к, де

зир у/1/ (х, х*).І'£сі/аі

хєУіиУ2 V І=1

(1.42)

хєЦиі^

Наведена теорема не доводить збіжності функції Ьтр (х),

формованої відповідно до алгоритму поділяючої функції, то-

му що вона не накладає ніяких обмежень на статистику пре-

д’явлення зображень у процесі навчання.

Насамперед, для правильного поділу множин 14 і 14 не-

обхідна досить представницька навчальна послідовність. Це

означає, що точки, які відповідають зображенням з навчаль-

ної послідовності, повинні бути досить добре розкидані по

множинах 14 і 14-

ТЕОРЕМА 4. Нехай множини 14 й 14 у просторі X такі,

що існує поділяюча функція, що задовольняє умові (1-41),

яка може бути представлена розкладанням (1.17). Нехай

функція І/ (х, х*) обмежена при х Є 14 014- Припустимо, що

появи зображень з навчальної послідовності — по суті неза-

лежні випадкові події, і яким би не було п, до п-го кроку ал-

горитму існує строго позитивна імовірність виправлення по-

милки за умови, що до цього кроку не відбулося повного по-

ділу МНОЖИН 14 І 14- Тоді з імовірністю, рівною 1, для кожної

реалізації алгоритму знайдеться таке скінченне число т, що

пт (х) =

> 0,

< 0,

якщо х Є 14;

якщо х Є 14-

(1.43)

Тобто процес поділу множин з імовірністю Р — 1 здійсню-

ється за скінченне число кроків.

1.8. Синтез екстремальної моделі (алгоритму) РО

47

1.8. Синтез екстремальної моделі (алгоритму) РО

Серед множини математичних задач, що виникають на

рівні моделей РО, варто виділити задачу синтезу математи-

чної моделі (чи алгоритму), оптимальної за якістю розпізна-

вання образів у даному класі моделей. Звичайно задається

спосіб побудови об’єктів кожного класу оцінювання для ал-

горитму з даного класу моделей, а також, яку частку об’є-

ктів він класифікує правильно (тобто відносить до задано-

го класу). Отримана величина усереднюється по класам і є

функціоналом якості РО. Завдання полягає в тому, щоб для

заданого класу моделей знайти алгоритм (модель) з макси-

мальним значенням функціонала якості (ФЯ) [19]

9?(Л) = ф(?}. (1.44)

1. Наприклад, може бути заданий наступний закон пород-

ження класів і 12г- Нехай описи І (ш) об’єктів 8 є набо-

рами числових ознак {аі (5),..., ап (5)} = а (5), де —оо <

а.і (5) < +оо, і — 1,п. Нехай у п-вимірному просторі задані два

нормальних розподіли з математичним сподіванням ті, т.2 і

дисперсією &1, Провадиться випадковий вибір точок (опи-

сів) і розігрується за заданими законами клас, у який вони зара-

ховуються. Після цього об’єкт 8, занесений, наприклад, у клас

12і з імовірністю р, зараховується до навчальної вибірки, а з

імовірністю (1 — р) — до контрольної, те ж саме виконується

і з об’єктами з класу 12г- Нехай сформовані таким чином на-

вчальні і контрольні вибірки. У навчальну вибірку зарахова-

ні об’єкти 511,512,..., 8іт Є 12і і 821,822, >821 Є 12г, а в кон-

трольну вибірку — 531,5з2, і 8^ Є 12] і 641,842,..., 8±и Є 12г-

У моделі будується алгоритм А, що за описами І (5ц),...,

- ..,1 (8іт), І (821(821) дає максимальне значення ФЯ

9?(Л) = де ір'А — число об’єктів з контрольної вибірки,

правильно класифікованих алгоритмом Л, </?" = и + V — за-

гальне число об’єктів у контрольній вибірці.

48

Розділ 1. Основи математичної теорії розпізнавання образів

2. Більш стандартним є підхід, у якому при фіксованій

початковій інформації /о і моделі потрібно знайти алгоритм,

що дозволяє максимально точно класифікувати дану сукуп-

ність Зі, і — 1,771 контрольних об’єктів, приналежність яких

класам Н2, • - , відома. Природно, що інформація типу

Зі Є ІД і Зі Є іїк не вводиться в алгоритм. Зокрема, можна

сформувати наступний клас задач синтезу експерименталь-

ної моделі (алгоритму) розпізнавання.

Нехай дані описи об’єктів І (5і), І (52) (Зт) із кла-

су $7! і ЦЗт+і), І(Зт+2), • • •, І (Зд) з класу П2, де І (&) =

(хц, хі2,..., хцу). Будується /?-модель, розбивка провадиться

гіперплощиною

N

/ (х) = = 0. (1-45)

7=1

Параметрами моделі є невідомі коефіцієнти аі,а2, , адчі,

вирішальне правило таке: якщо / (/(5і)) > 0, то Зі Є ІД,

якщо / (І (Зі)) < 0, то З, Є И2. Виписавши ці умови для всіх

об’єктів 5і, 32,..., 8т, • -чЗд, ми одержимо систему лінійних

нерівностей з невідомими аі, а2,..., ал+і :

а]Жц + ... + а//Хідг + <^+і > 0;

+ • + а^Хтіу + адг+1 > 0;

Оі^т+і,і + - - + аічхт+і'іу + ^N+1 < 0;

(1-46)

Оі + • • - + а^Хдіи + а N41 < 0.

Для синтезу шуканого алгоритму потрібно знайти макси-

мальну сумісну підсистему в (1.46). Вирішивши її, одержимо

шукані значення параметрів , а2,..., адг+і-

Розділ 2

МОДЕЛІ ТА АЛГОРИТМИ НАВЧАННЯ

ТА САМОНАВЧАННЯ В ЗАДАЧАХ

РОЗПІЗНАВАННЯ ОБРАЗІВ

2.1. Класифікація моделей навчання.

Формальна модель навчання

Навчання — це одна з невід’ємних властивостей будь-якої

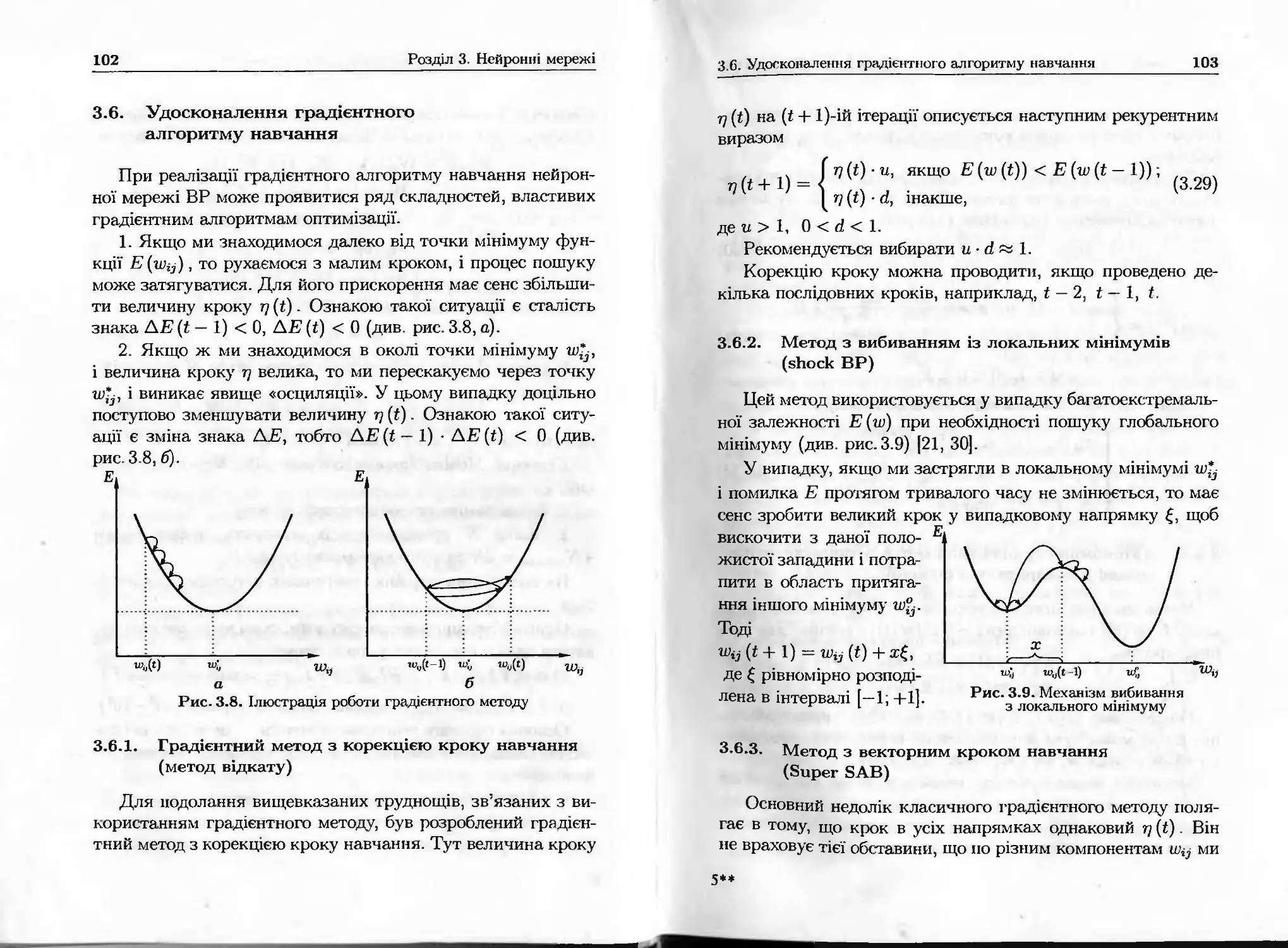

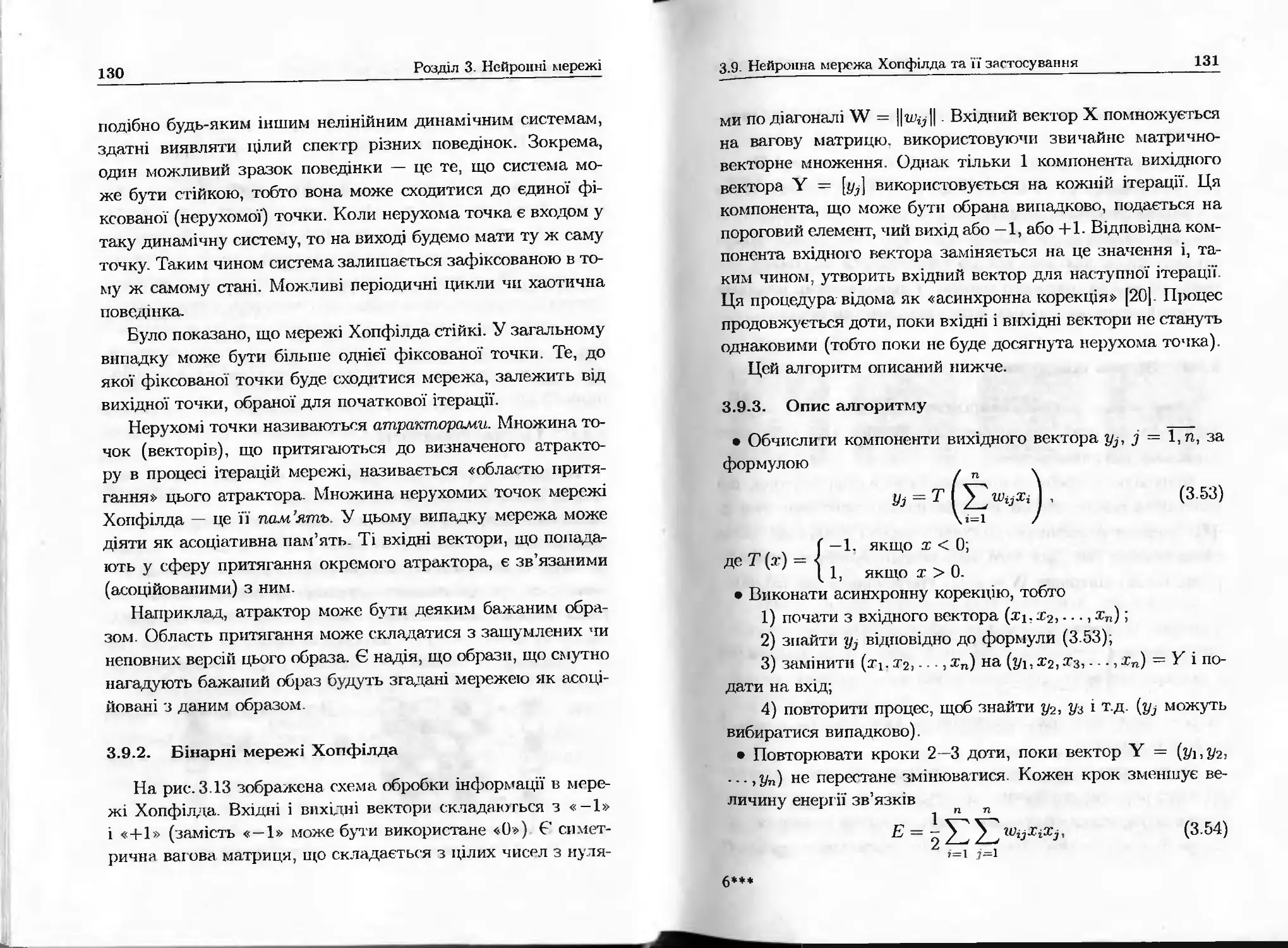

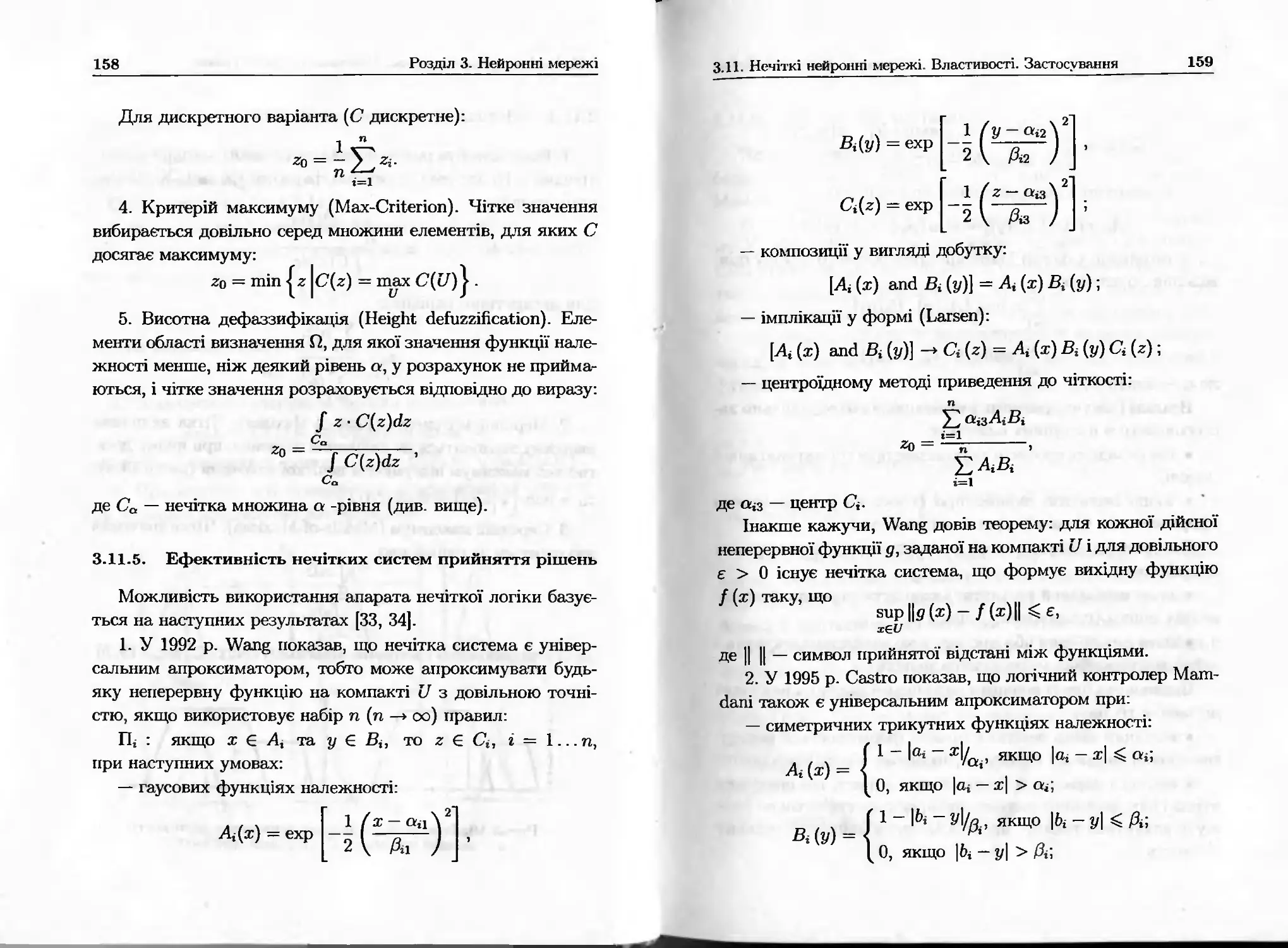

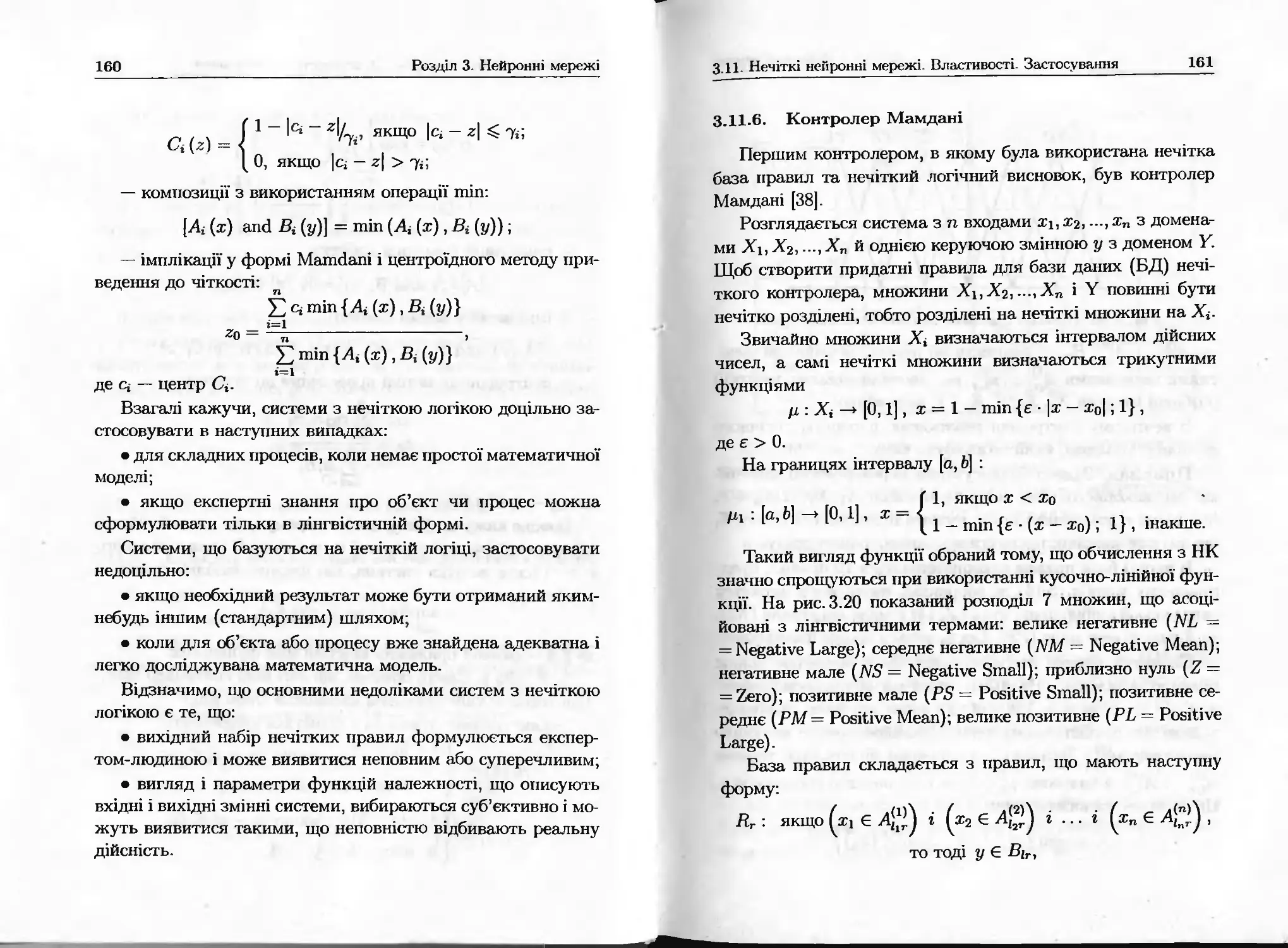

інтелектуальної системи (ІС), як природної, так і штучної,