Автор: Іванченко Г.Ф.

Теги: навчальний посібник штучний інтелект інформаційни системи

ISBN: 978-966-483-544-9

Год: 2011

Текст

МІНІСТЕРСТВО ОСВІТИ І НАУКИ, МОЛОДІ ТА СПОРТУ УКРАЇНИ Державний вищий навчальний заклад «КИЇВСЬКИЙ НАЦІОНАЛЬНИЙ ЕКОНОМІЧНИЙ УНІВЕРСИТЕТ імені ВАДИМА ГЕТЬМАНА»

Г. Ф. Іванченко

СИСТЕМИ

ШТУЧНОГО ІНТЕЛЕКТУ

Навчальний посібник

Рекомендовано Міністерством освіти і науки України

Д,1І1 КНЕУ КИЇВ 2011

УДК 004.853 ББК 32.813 1-23

Рецензенти В. Я. Рубан, д-р екон. наук, проф.

(Київський національний університет технологій та дизайну)

О. О. Денісова, канд. екон. наук, доц.

(ДВНЗ «Київський національний економічний університет імені Вадима Гетьмана)

4 В. В. Гавриленко, д-р фіз.-мат. наук, проф.

(Національний транспортний університет)

Редакційна колегія факультету інформаційних систем і технологій

Голова редакційної колегії О. Д. Шарапов, канд. техн. наук, проф.

Відп. секретар редакційної колегії С. С. Ващаєв, канд. екон. наук, доц.

Члени редакційної колегії: 3. П. Бараник, д-р екон. наук, доц.; Г. І. Великоіваненко, канд. фіз.-мат. наук, доц.; В. В. Вітпінський, д-р екон. наук, проф.; В. К. Галіцин, д-р екон. наук, проф.; І. А. Джалладова, д-р фіз.-мат. наук, доц.; Ю. М. Красюк, канд. пед. наук; С. Ф. Лазарева, канд. екон. наук, доц.; О. П. Степаненко, канд. екон. наук, доц.; С. В. Устенко, д-р екон. наук, доц.

Рекомендовано до друку Вченою радою КНЕУ Протокол від 23.11.11 No З

Іванченко Г. Ф.

1-23 Система штучного інтелекту: навч. посіб. / Г. Ф. Іванченко. — К.: КНЕУ, 2011. — 382, [2] с.

ISBN 978-966-483-544-9

Посібник присвячений фундаментальним проблемам створення систем штучного інтелекту і наявним підходам до їх розв’язання. Розглядаються моделі подання знань, характеристики дедуктивного та індуктивного висновку, розпізнавання образів, сприйняття машиною навколишнього фізичного світу, конекціо- ністський підхід моделювання людського мозку і, нарешті, розуміння машиною природної мови.

Мета видання навчального посібника — забезпечити систематичний розгляд всього спектру тем, рекомендованих програмою для підготовки фахівців у галузі інформаційних систем та економічної кібернетики, включаючи як опис загальних підходів і принципів СШІ, так і алгоритмічних основ.

Призначений для спеціалістів у галузі інформаційних систем і технологій, магістрантів і докторантів вищих навчальних закладів економічних і технічних спеціальностей, а також усіх тих, хто не уявляє свого майбутнього без розвитку систем штучного інтелекту.

УДК 004.853 ББК 32.813

о.

Розповсюджувати та тиражувати без офіційного дозволу КНЕУ заборонено

ISBN 978-966-483-544-9

© Г. Ф. Іванченко, 2011 ©КНЕУ, 2011

Зміст

Передмова 6

Вступ 7

Розділ 1. БАЗОВІ ПОНЯТТЯ ШТУЧНОГО ІНТЕЛЕКТУ 11

Тема 1. Історичний та філософський аспекти проблеми штучного інтелекту 11

1.1. Історія розвитку систем штучного інтелекту . . 12

1.2. Соціальні результати інтелектуалізації комп’ютерних

технологій 20

1.3. Тест Тюринга і фактичний діалог 30

1.4. Сучасні дослідження напряму штучного інтелекту 32

1.5. Інтелектуальні роботи 36

Розділ 2. ПОДАННЯ ЗНАНЬ У СИСТЕМАХ ШТУЧНОГО

ІНТЕЛЕКТУ 45

Тема 2. Загальна характеристика моделей подання знань 45

2.1. Формалізація знань у системах штучного інтелекту 46

2.2. Концептуальні властивості знань 58

2.3. Моделі подання знань 66

2.4. Логічна форма моделі знань та формальна система 68

2.5. Числення висловів ! . . 73

2.6. Числення предикатів .... 81

2.7. Моделі знань на основі продукцій .. <» 90

2.8. Асоціативна модель знань 110

2.9. Семантичні мережі . 112

2.10. Фрейми /&.. 126

2.11. Об’єктно-орієнтована модель знань 145

2.12. Мережеві та інші моделі знань 148;

РОЗДІЛ 3. ОСНОВНІ МОДЕЛІ ВИСНОВКУ 161

Тема 3. Загальна характеристика дедуктивного та індуктив-^ ^ ного висновку 161

3.1. Формулювання завдання дедуктивного висновку 162,

4

Г.Ф. Іванченко

3.2. Стандартизація предикатних формул. 1631

3.3. Метод Ербрана 166

3.4. Принцип резолюції. 167

3.5. Стратегії пошуку 170

3.6. Використання принципу резолюції. . 171J

3.7. Принцип резолюції і мова Prolog 177

3.8. Індуктивні схеми міркувань 182

Тема 4. Висновки в умовах ненадійних або неповних знань... 187'

4.1. Види невизначеності. . . 187

4.2. Баєсовський метод 189

4.3. Метод коефіцієнтів упевненості 194$

4.4. Теорія свідоцтв Демпстера—Шефера 198

4.5. Нечіткі множини й нечітка логіка. . . 200

4.6. Приклади використання нечіткої логіки. 206

4.7. Неповнота знань та немонотонний висновок 215

Розділ 4. ШТУЧНІ НЕЙРОННІ МЕРЕЖІ 224

Тема 5. Конекціоністський підхід як спроба моделювання людського мозку 224

5.1. Персептрони та зародження штучних нейронних мереж .. 225

5.2. Біологічна модель штучних нейронних мереж. 231

5.3. Штучний нейрон та функції активації 234і

5.4. Одношарова та багатошарова нейронні мережі 2403

5.5. Радіально-базисні нейронні мережі . . j. 250

5.6. Мережі Хопфілда зі зворотними зв’язками 252

5.7. Статичні мережі Хопфілда і машина Больцмана 256

5.8. Нейронні мережі Хопфілда і Хеммінга 258

Тема 6. Навчання нейронної мережі v 266

6.1. Навчання нейронної мережі з учителем і без учителй^.. ?266

6.2. Особливості алгоритмів навчання персептрона 269

6.3. Метод сигнального навчання Хебба /г. .. . 3S. 273

6.4. Алгоритм навчання Кохонена. . 276

6.5. Алгоритм навчання Коші 278

6.6. Комбінування зворотного поширення з навчанням Коші.. . 279

6.7. Процедура зворотного поширення .... 281

Розділ 5. РОЗПІЗНАВАННЯ ОБРАЗІВ ТА АНАЛІЗ

ЗОБРАЖЕНЬ. 289

Тема 7. Основні поняття теорії розпізнавання образів .. і 7?. 289

7.1. Класифікація систем розпізнавання 290

7.2. Класи та їх властивості. . 299

СИСТЕМИ ШТУЧНОГО ІНТЕЛЕКТУ

5

7.3. Класифікація основних методів розпізнавання 301

7.4. Розпізнавання в просторі ознак. . 302

7.5. Гіпотеза компактності. . . 307

7.6. Метод найближчого сусіда.... 313

7.7. Баєсівські методи розпізнавання. ... 314

7.8. Попередня обробка сигналів та зображень. . 315^

7.9. Алгоритм К середніх у СРО 322

7.10. Алгоритм косіаіа — ітеративний аналіз даних 324

7.11. Розпізнавання та обробка природної мови 328(

А

Бібліографія.. 336 /

Додатки 338

ПЕРЕДМОВА

Дисципліна «Системи штучного інтелекту» відіграє фундаментальну роль у підготовці фахівців у галузі інформатики й обчислювальної техніки. Різні навчальні курси з проблематики систем штучного інтелекту (СШІ) включено до навчальних планів багатьох університетів. Асоціаціями ACM, AIS і АІТР розроблено програму підготовки фахівців у галузі інформаційних систем, яку рекомендовано для міжнародного використання. Програмою передбачено в рамках дисципліни «Системи штучного інтелекту» розгляд таких тем: історія, основні поняття і напрями розвитку; подання завдань і простору пошуку рішень; основні стратегії управління висновком (пошук у глибину і в ширину, прямий і зворотний висновок); евристичний пошук; представлення знань; прикладні експертні системи й оболонки; нечітка логіка і нечіткий висновок; машинне навчання; розпізнавання образів; нейронні мережі; обробка природної мови; розпізнавання мови і машинний зір.

Мета видання навчального посібника — забезпечити систематичний розгляд всього спектра тем, рекомендованих для вивчення програмою підготовки фахівців у галузі інформаційних систем, включаючи й опис загальних підходів та принципів СШІ, і алгоритмічні основи.

Для опанування навчального посібника потрібні знання в галузі програмування і ЕОМ, вищої математики, теорії інформації та математичної статистики. Навчальний посібник заснований на матеріалах лекцій, прочитаних автором для студентів старших курсів ДВНЗ «Київський національний економічний університет імені Вадима Гетьмана» на кафедрі інформаційних систем в економіці.

Книга розрахована на студентів, що навчаються за напрямом підготовки 0403, 0804 «Комп’ютерні науки» спеціальності 6.080400, 7.080404, 8.080404, 7.04030302, 8.04030302 «Інтелектуальні системи прийняття рішень». Вона буде також корисна студентам, що навчаються за напрямами «Комп’ютерні науки», «Комп’ютерна інженерія», «Економічна кібернетика», «Системні науки та кібернетика», «Системи і методи прийняття рішень» і розробникам інтелектуальних систем.

ВСТУП

Людина є інтелектуальною від природи, і цей інтелект було вироблено упродовж мільйонів років еволюції. Вона в змозі вирішувати інтелектуальні завдання.. Багато хто вважає, що розуміє значення слова «інтелект», але якщо попросити дати його визначення, в переважній більшості чіткої відповіді не почуємо.

І справді, дати таке визначення, яке задовольняло б усіх, очевидно, неможливо. Втім це не заважає оцінювати інтелектуальність на інтуїтивному рівні.

Живий мозок, як інформаційна машина, постійно взаємодіє з об’єктним світом. Лише малу частку своїх здібностей він виділяє для усвідомлюваної творчості. А сам механізм свідомості — це безперервний процес, він працює, навіть коли ми спимо й нічого не усвідомлюємо. Усвідомлення себе — це лише один з численних процесів творчого (тобто неавтоматичного) сприйняття зовнішнього світу. Сприйняття світу не можна цілком автоматизувати, оскільки розумна істота повинна бути готова до непередба- чуваної зміни в навколишньому світі.

Діяльність мозку (що має інтелект), яка спрямована на вирішення інтелектуальних завдань, ми називатимемо мисленням, або інтелектуальною діяльністю. Інтелект і мислення органічно пов’язані з доведенням теорем, логічним аналізом, розпізнаванням ситуацій, плануванням поведінки, природною мовою і управлінням в умовах невизначеності. Характерними рисами інтелекту, що виявляються в процесі вирішення завдань, є здібність до навчання, узагальнення, накопичення досвіду (знань і навичок) й адаптація до умов, що змінюються, в процесі рішення задач. Завдяки цим якостям інтелекту мозок може легко перебудовуватися з одного завдання на друге. Таким чином, мозок, наділений інтелектом, є універсальним засобом вирішення широкого кола завдань (зокрема неформалізованих) для яких немає стандартних, зазадалегідь відомих методів розв’язання.

Слід враховувати, що існують інші, суто поведінкові (функціональні) визначення. Так, за А. Н. Колмогоровим, будь-яка мате¬

8

Г.Ф. Іванчвнко

ріальна система, з якою можна досить тривалий час обговорювати проблеми науки, літератури й мистецтва, має інтелект. Іншим прикладом поведінкового трактування інтелекту може служити відоме визначення А. Тюринга: в різних кімнатах знаходяться люди і ЕОМ. Вони не можуть бачити одне одного, та мають можливість обмінюватися інформацією (наприклад, за допомогою електронної мережі чи пошти). Якщо в процесі діалогу між учасниками тесту людям не вдається встановити, що один з учасників

— ЕОМ, то таку програмно-машинну систему можна вважати такою, що має інтелект.

До речі, А. Тюринг запропонував цікавий план імітації мислення:

«Чому нам замість того, щоб намагатися створити програму, що імітує інтелект дорослої людини, не спробувати створити програму, яка імітувала б інтелект дитини? Адже інтелект дитини коли отримує відповідне виховання, стає інтелектом дорослої людини. Наша думка полягає в тому, що пристрій, йому подібний, можна легко запрограмувати. Таким чином, ми розділимо нашу проблему на дві частини: на завдання побудови «програми- дитини» і завдання «навчання цій програми».

Забігаючи наперед, можна сказати, що саме цей шлях використовують майже всі системи штучного інтелекту (СШІ). Адже зрозуміло, що практично неможливо закластиі всі знання в досить складну систему. Крім того, тільки на цьому шляху виявляться перераховані вище ознаки інтелектуальної діяльності (накопичення досвіду, адаптація тощо).

Постійний динамічний контакт з об’єктним світом є обов’язковою умовою і життя, і розуму. А повноцінне розумне життя можливе лише в культурному середовищі серед людей. Для того щоб визнати істоту розумною, вона повинна пристосуватися до людської культури. Якщо папуга зможе пройти тест А.Тюринга, то ніхто не сумніватиметься, що він має свідомість, оскільки це тест на наявність людської свідомості.

Критерій розуміння — це працюючий самонавчальний алгоритм. Розробивши алгоритм (технологію) самонавчання, або універсальної адаптації, і забезпечивши цим алгоритмом штучну істоту, ми забезпечуємо його засобом для розвитку свідомості й усвідомлення себе. У математиці й кібернетиці клас завдань певного типу вважається вирішеним, коли для її вирішення встановлено алгоритм.

СИСТЕМИ ШТУЧНОГО ІНТЕЛЕКТУ

9

Пошук алгоритму для завдань цього типу пов’язано з тонкими і складними міркуваннями, що вимагають неабиякої винахідливості й високої кваліфікації. Зазвичай вважають, що для подібної діяльності потрібно задіяти інтелект людини. Завдання певного типу, пов’язані з пошуком алгоритму вирішення, називатимемо інтелектуальними.

Щодо завдань, алгоритми вирішення яких вже встановлені, як відзначає відомий фахівець у галузі штучного інтелекту М. Мінський, «є перебільшенням приписувати їм такі містичні властивості, як «інтелектуальність». Насправді, після того, як такий алгоритм вже знайдено, процес вирішення відповідних завдань стає таким, що його в змозі точно виконати людина або обчислювальна машина (належним чином запрограмована) або робот, що не має анінайменшої уяви про сутність самого завдання. Потрібно тільки, щоб робот був спроможний виконувати ті елементарні операції, з яких складається процес, і, крім того, педантично й акуратно керувався запропонованим алгоритмом. Така штучна система, діючи, як кажуть в таких випадках, машинально, може успішно вирішувати будь-яке завдання цього типу.

Тому уявляється цілком природним виключити з класу інтелектуальних завдання, для яких існують стандартні методи вирішення. Як приклад можуть служити суто обчислювальні задачі розв’язання системи лінійних рівнянь алгебри, чисельна інтеграція диференціальних рівнянь тощо. Для вирішення подібних завдань є стандартні алгоритми, що є певною послідовністю елементарних операцій, яка може бути легко реалізована у вигляді програми для обчислювальної машини. На противагу цьому, для широкого класу інтелектуальних завдань, як-от розпізнавання образів, мови, гра в шахи, доведення теорем тощо, формальне розбиття процесу пошуку рішень на окремі елементарні кроки часто виявляється вельми складним, навіть якщо насправді їх вирішення складним не видається.

Таким чином, ми можемо перефразувати визначення інтелекту, як універсальний супералгоритм, який спроможний створювати алгоритми вирішення конкретних завдань. Навряд чи є сенс протиставляти поняття штучного інтелекту і інтелекту взагалі. Тому слід спробувати визначити поняття інтелекту незалежно від його походження.

Пропонований навчальний посібник є основним під час вивчення дисциплін бакалаврського та магістерського рівнів: «Сис¬

10

Г.Ф. Іванчвнко

теми штучного інтелекту», «Системи розпізнавання образів», «Нейромережеві системи», «Прикладні систем штучного інтелекту», які мають сформувати у студентів фундаментальні теоретичні знання та практичні навички з теорії проектування систем штучного інтелекту. Ще одне цікаве зауваження: професія програміста, виходячи з наших визначень, є однією з найінтелектуа- льніших, оскільки продуктом діяльності програміста є програми

— алгоритми в чистому вигляді.

Штучний інтелект (ШІ) можна визначити як галузь комп’ютерної науки, що займається автоматизацією розумної поведінки. Це визначення найточніше відповідає змісту навчального посібника, оскільки в ньому ШІ розглядається як частина комп’ютерної науки, яка спирається на її теоретичні й прикладні принципи. Ці принципи зводяться до структур даних, використовуваних для представлення знань, алгоритмів застосування цих знань, а також мов і методик програмування.

БАЗОВІ ПОНЯТТЯ ШТУЧНОГО ІНТЕЛЕКТУ

Тема 1

ІСТОРИЧНИЙ ТА ФІЛОСОФСЬКИЙ АСПЕКТИ ПРОБЛЕМИ ШТУЧНОГО ІНТЕЛЕКТУ

Перелік знань та навичок

Після опанування теми студент має знати:

• історичні етапи систем штучного інтелекту;

• соціально-філософські наслідки створення та впровадження в життя систем штучного інтелекту;

• переваги та заперечення тесту Тьюринга і фактичний діалог;

• сучасні напрями дослідження у СШІ та їх класифікацію;

• узагальнену структуру інформаційної системи інтелектуального робота;

• три закони роботехніки Айзека Азімова.

Має вміти:

• пояснити визначення предмета теорії штучного інтелекту та системи штучного інтелекту (СШІ);

• навести приклади з розвитку цивілізації інформаційних революцій;

• пояснити спроможність моделювання мислення людини;

• пояснити місце інтелектуальної системи у СШІ;

• які є підходи в моделюванні інтелектуальної діяльності людини?

• описати та використати процедуру тесту Алана Тюринга;

• класифікувати напрямки досліджень у галузі штучного інтелекту за Хантом;

• визначати сфери застосування СШІ;

• скласти загальну характеристику символьного та конекціоні- стського підходів до створення систем штучного інтелекту.

12

Г.Ф. Іванченко

ЗМІСТ ПИТАНЬ ТЕМИ

1.1. Історія розвитку систем штучного інтелекту

Термін «штучний інтелект» — Artificial Intelligence (АІ) — був запропонований в 1956 р. на семінарі, присвяченому рішенню логічних задач, з аналогічною назвою в Дартсмудському коледжі (СІЛА).

Термін інтелект (intelligence) походить від латинського intellectus, що означає розум, глузд, розумові здібності людини. Відповідно штучний інтелект — ШІ (АІ) звичайно тлумачиться як властивість автоматичних систем брати на себе окремі функції інтелекту людини, наприклад, обирати й ухвалювати оптимальні рішення на основі раніше одержаного досвіду й раціонального аналізу зовнішніх дій.

В історії людства можна виділити кілька інформаційних революцій, які були переламними моментами в розвитку цивілізації.

Перша була пов’язана з появою мови. Мова дала можливість передавати знання від одного індивідуума до ідругого і, отже, зберігати його з покоління в покоління. І

Друга інформаційна революція була пов’язана з появою писемності. Писемність дозволила обмінюватися знаннями індивідуумам без безпосереднього контакту і, таким чином істотно збільшити доступність і надійність збереження знань.

Третя революція — поява книгодрукування ще збільшило доступ до знань і зробило можливим їх масове поширення і збереження. ^

Четверта революція була пов’язана з появою електрозв’язку електричним засобами запису знань (інформації).

П’ята революція, яку ми переживаємо зараз, пов’язана з появою масових ЕОМ, об’єднаних в мережі, і які мають потужні засоби для зберігання, накопичення й використання знань. В межах цієї інформаційної революції можна виділити також ряд етапів, останнім з яких є поява систем штучного інтелекту, або систем, заснованих на знаннях. Загалом п’ята революція дала змогу зберігати й мати швидкий доступ практично до необмеженого об’єму знань. Крім того, завдяки системі штучного інтелекту

СИСТЕМИ ШТУЧНОГО ІНТЕЛЕКТУ

13

з’явилася можливість вперше пов’язати безпосередньо знання з матеріальним виробництвом (або в більш загальному випадку — з навколишнім матеріальним світом), виключивши людину як проміжну ланку. Мало того, системи самі можуть виробляти нові знання. Для цього служать засоби видобування (або придбання) знань, наприклад з баз даних шляхом виявлення закономірностей і формулювання цих закономірностей у вигляді баз знань. У комп’ютерному світі набули поширення дослідження й розробки в галузі так званих технологій «data mining» — видобування корисних даних (знань) з великої їх кількості, зокрема з неструкту- рованих даних. %

Сучасна інформатика багато в чому зобов’язана дослідженням у галузі штучного інтелекту. Наприклад, багато розділів дослідження операцій з’явилося з розроблених методів обмеження перебирання варіантів при вирішенні завдань ШІ. На термінологію й методи розробки компіляторів вплинули дослідження в галузі машинного перекладу. Засоби розпізнавання й синтезу мови зараз вже є невід’ємною часткою деяких спеціалізованих інформаційних систем і претендують на широке використання в операційних системах. Системи розпізнавання тексту є звичайною часткою офісних програмних систем (друкарський текст) або кишенькових комп’ютерів перекладачів. Об’єктно-орієнтоване програмування виросло з представлення знань у вигляді фреймів, введених американським ученим Мінським. Нейромережеві технології і технології експертних систем успішно застосовують у системах економічного аналізу і прогнозування. Приклади можна було б продовжити.

Ці роботи поклали початок першому етапу досліджень у галузі ШІ, пов’язаному з розробкою програм з вирішення завдань на основі застосування різноманітних евристичних методів.

Евристичний метод вирішення завдання при цьому розглядався як властивий людському мисленню «взагалі», для якого характерно виникнення припущень про напрями вирішення завдання з подальшою їх перевіркою. Йому протиставлявся використовуваний в ЕОМ алгоритмічний метод, який інтерпретувався як механічне здійснення заданої послідовності кроків, що детерміновано приводить до правильної відповіді. Трактування евристичних методів вирішення завдань як суто людської діяльності й зумовила появу та подальше поширення терміну ШІ. Так, під час опису своїх програм Ньюелл і Саймон наводили результати порівняння записів

14

Г.Ф. Іванченко

доведень теорем у вигляді програм із записами міркування людини як доводи, що їхні програми моделюють людське мислення.

На початку 70-х років вони запропонували загальну методику складання програм, що моделюють мислення. Приблизно в той час, коли роботи Ньюелла і Саймона стали привертати до себе увагу, в Массачусетському технологічному інституті, Стенфорд- скому університеті і Стенфордскому дослідницькому інституті, де також сформувалися дослідницькі групи в галузі ШІ. На противагу раннім роботам Ньюелла і Саймона ці дослідження більше належали до формальних математичних уявлень. Способи розв’язання задач у цих дослідженнях розвивалися на основі розширення математичної й символічної логіки. А моделюванню людського мислення надавалося другорядне значення.

На подальші дослідження ШІ великий вплив справила поява методу резолюцій Робінсона, заснованого на доведенні теорем у логіці предикатів. При цьому визначення терміну ШІ зазнало змін.

Метою досліджень у ШІ стала розробка програм, здатних вирішувати «людські завдання». Так, один із знаних дослідників ШІ того часу Р. Бенерджі в 1969 році писав: «Галузь досліджень, яку зазвичай називають ШІ, мабуть, можна представити як сукупність методів і засобів аналізу та конструювання машин, здатних виконувати завдання, з якими до недавнього касу могла впоратися тільки людина. При цьому за швидкістю й ефективністю машини мали бути порівняні з людиною». Функціональний підхід до спрямування досліджень з ШІ зберігся в основному до теперішнього часу, хоча й нині ряд учених, особливо психологів, намагаються оцінювати результати робіт з ШІ з позицій їхньої відповідності людському мисленню. х

Дослідницьким полігоном для розвитку методів ШІ на першому етапі були різноманітні ігри, головоломки, математичні задачі. Деякі з цих задач стали класичними в літературі з ШІ (задачі про мавпу і банани, місіонерів і людоїдів, Ханойську башту, гра в 15 та інші). Вибір таких задач обумовлювався простотою і ясністю проблемного середовища, її відносною негроміздкістю, можливістю досить легкого підбору і навіть штучного конструювання «під метод». Розквіт подібних досліджень припадає на кінець 60-х років, згодом почалися перщі спроби застосування розроблених методів для завдань, що вирішуються не в штучних, а в реальних проблемних середовищах.

СИСТЕМИ ШТУЧНОГО ІНТЕЛЕКТУ

15

Необхідність дослідження систем ШІ за їх функціонування в реальному світі привело до постановки завдання створення інтегральних роботів. Проведення таких робіт можна вважати другим етапом досліджень з ШІ. У Стенфордскому університеті і не тільки було розроблено експериментальні роботи, що функціонують в лабораторних умовах. Проведення цих експериментів довело необхідність розв’язання проблеми представлення знань про середовище функціонування, і одночасно недостатню дослідже- ність таких проблем, як зорове сприйняття, побудова складних планів поведінки в динамічних середовищах, спілкування з роботами на природній мові.

Ці проблеми були точніше сформульовано і поставлено перед дослідниками у середині 70-х рр., з початком третього етапу досліджень систем ШІ. Як його характерна межа — зміщення центру уваги дослідників із створення автономно функціонуючих систем, самостійно вирішуючих у реальному середовищі висунуті перед ними завдання, до створення людиномашинних систем, інтегруючих в єдине ціле інтелект людини і можливості ЕОМ для досягнення загальної мети — вирішення завдання, інтегральною людиномашинною системою.

Стало зрозуміло, що поєднання доповнювальних одне одного можливостей людини і ЕОМ дає змогу обійти гострі кути шляхом перекладання на людину тих функцій, які поки що не доступні для ЕОМ. На перший план висувалася не розробка окремих методів машинного вирішення завдань, а розробка методів, засобів, що забезпечують тісну взаємодію людини й обчислювальної системи упродовж всього процесу вирішення завдання з можливістю оперативного внесення людиною змін під час цього процесу.

Розвиток досліджень з ШІ в цьому напрямі обумовлювався також різким зростанням виробництва засобів обчислювальної техніки і також істотним їх здешевленням, що робить їх потенційно доступними для ширшого кла користувачів.

Із сказаного вище, випливає основна філософська проблема в галузі ШІ — спроможність або неспроможність моделювання мислення людини. У разі якщо колись буде отримана негативна відповідь на це питання, вся решта питань курсу не матиме й щонайменшого сенсу.

Отже, починаючи дослідження ШІ, ми заздалегідь припускаємо позитивну відповідь. Наведемо кілька міркувань, які підводять нас до відповіді.

16

Г.Ф. Іванченко

1. Перший доказ є схоластичним і доводить, що ШІ і Біблія не суперечать одне одному. Мабуть, навіть люди далекі від релігії, знають слова священного писання: «І створив Господь людину за образом і подобою свою...». Виходячи з цих слів, ми можемо припустити, що оскільки Господь, по-перше, створив нас, а по- друге, ми за своєю суттю подібні до нього, то ми цілком можемо створити когось за образом і подобою людини.

2. Створення нового розуму біологічним шляхом для людини справа цілком природна. Спостерігаючи за дітьми, ми бачимо, що більшу частину знань вони набувають шляхом навчання, а не як закладену в них заздалегідь базу знань на рівні хромосом. Таке твердження на сучасному рівні не доведене, але за зовнішніми ознаками все має саме такий вйгляд. Навколишнє середовище створює знання.

3. Те, що раніше здавалося вершиною людської творчості —

гра в шахи, шашки, розпізнавання зорових і звукових образів, синтез нових технічних рішень, на практиці виявилося не такою вже складною справою (тепер робота ведеться не на рівні можливості або неможливості реалізації перерахованого, а з метою знаходження найбільш оптимального алгоритму). Тепер часто ці проблеми навіть не відносять до проблем ШІ. Є сподівання, що й повне моделювання мислення людини виявиться не такою вже й складною справою. І

4. З проблемою відтворення свого мислення тісно межує проблема можливості самовідтворення.

Здатність до самовідтворення тривалий час вважали прерогативою живих організмів. Проте деякі явища, що відбуваються в неживій природі (наприклад, зростання кристалів, синтез складних молекул копіюванням), дуже схожі на самовідтворення. На початку 50-х років Дж. фон Нейман почав ґрунтовно висчати самовідтворення і заклав основи математичної теорії автоматів, що «самовідтворюються». Так само він довів теоретично можливість їх створення.

Існують також різні неформальні докази можливості самовідтворення, але для програмістів найяскравішим доказом, мабуть, буде існування комп’ютерних вірусів та програмних агентів.

5. Принципова можливість автоматизації розв’язання інтелектуальних задач за допомогою ЕОМ забезпечується її алгоритмічною універсальністю. Алгоритмічна- універсальність ЕОМ означає, що на них можна програмно реалізовувати (тобто представи¬

СИСТЕМИ ШТУЧНОГО ІНТЕЛЕКТУ

17

ти у вигляді машинної програми) будь-які алгоритми перетворення інформації — чи то обчислювальні алгоритми, алгоритми управління, пошуку доведення теорем або композиції мелодій. При цьому ми маємо на увазі, що процеси, що породжуються цими алгоритмами, є потенційно здійсненними, тобто що вони здійснені в результаті скінченного числа елементарних операцій. Практична здійсненність алгоритмів залежить від наявних у нашому розпорядженні засобів, які можуть мінятися з розвитком техніки. Так, з появою швидкодіючих ЕОМ стали практично здійсненними й такі алгоритми, які раніше були тільки потенційно здійсненними.

Властивість алгоритмічної універсальності не обмежується констатацією того, що для всіх відомих алгоритмів виявляється можливою їх програмна реалізація на ЕОМ.

Проте не слід вважати, що обчислювальні машини і роботи можуть вирішувати будь-які завдання. Аналіз різноманітних завдань спонукав математиків до чудового відкриття. Було суворо доведено існування таких типів завдань, для яких неможливий єдиний ефективний алгоритм, що розв’язував би всі завдання цього типу; неможливе вирішення завдань такого типу і за допомогою обчислювальних машин. Цей факт сприяє кращому розумінню того, що можуть робити машини і чого вони зробити не можуть. Насправді, твердження про неможливість алгоритмічного розв’язання певного класу задач є не зізнанням того, що такий алгоритм нам не відомий і ніким ще не знайдений. Таке твердження є водночас і прогнозом на майбутнє, що подібні алгоритми не існують.

Припустимо, що людина створила інтелект, що перевищує власний. Що тепер станеться з людством? Яку роль відіграватиме людина? І взагалі, чи потрібно у принципі створювати ШІ?

Оскільки припускається, що людина не завдаватиме шкоди самому собі, а ШІ тепер є частиною цього індивідуума (не обов’язково фізична спільність), то автоматично виконуються всі три закони роботехніки. При цьому питання безпеки зміщуються в галузь психології і правоохорони, оскільки система (навчена) не робитиме нічого такого, чого не хотів би її власник.

Історично склалися три основні підходи в моделюванні ШІ.

У рамках першого підходу об’єктом досліджень є структура і механізми роботи мозку людини, а кінцева мета полягає в розкритті таємниць мислення. Необхідними етапами досліджень у цьому які є побудова моделей на основі психофізіологічних да-

18

Г.Ф. Іванченко

них, проведення експериментів з ними, висунення нових гіпотез щодо механізмів інтелектуальної діяльності, вдосконалення моделей тощо.

Другий підхід як об’єкт дослідження розглядає ШІ. Тут ідеться про моделювання інтелектуальної діяльності за допомогою обчислювальних машин. Метою робіт у цьому напрямі є створення алгоритмічного й програмного забезпечення обчислювальних машин, що дозволяє вирішувати інтелектуальні завдання не гірше за людину.

Нарешті, третій підхід орієнтований ,ра створення змішаних людино-машинних, або, як ще кажуть, інтерактивних інтелектуальних систем, на симбіоз можливостей природного і штучного інтелекту. Найважливішими проблемами в цих дослідженнях є оптимальний розподіл функцій між природним та штучним інтелектом й організація діалогу між людиною і машиною.

Перші штучні «люди» були механічними роботами. Так, у Давньому Єгипті була створена «оживаюча» механічна статуя бога Амона. У Гомера в «Іліаді» бог Гефест кував людиноподібні істоти-автомати. З легенд середньовіччя відома лялька, що створив Хома Аквінський. Вона світилася і вміла ходити й говорити.

У літературі ідею штучного створення людини обігрували багато разів: Галатея в «Пігмаліоні», Буратіно тата Карла, Ксаверій у «Золотому ланцюзі» А. Гріна тощо. І це булй вже не механічні статуї, а істоти, здатні мислити, висловлювати свої думки й удосконалюватися.

Родоначальником власне штучного інтелекту як штучного мислення інколи вважають середньовічного філософа, математика і поета Раймонда Луллія, який у XIII ст. спробував створити логічну систему для вирішення різних завдань на основі класифікації понять і комбінування.

Першими теоретичними розробками в галузі штучного інтелекту можна вважати праці Г. Лейбніца і Р. Декарта, які незалежно один від одного продовжили ідею універсальної класифікації наук (XVIII ст.).

Проте формування ШІ як наукового напряму розпочинається після створення ЕОМ (у 40-ві рр. XX століття) і кібернетики Н. Вінера, а оформлення ШІ в самостійну галузь знань відбулося в 50—60-ті рр. XX ст.

Спочатку роботи в галузі ШІ починалися з моделювання елементарних ігор у кубики, хрестики-нулики тощо, створення інте¬

СИСТЕМИ ШТУЧНОГО ІНТЕЛЕКТУ

19

лектуальних роботів і планування їх поведінки. Ці завдання є класичними під час навчання теоретичним основам ШІ. На їх ідеях були розроблені основні моделі представлення знань: про- дукційні, семантичні мережі, фрейми.

Та, вважають, першими, які зробили істотний внесок у становлення ШІ як науки: Ф. Розенблатт і У. Мак-Каллок, що створили в 1956—1965 рр. перші нейронні мережі і пристрій, що одержав назву «персептрон» (perceptron) [1, 2]; А. Нюелл, Дж. Шоу, Р. Саймон створили машину «Логік-теоретик» й інші творці «ви- рішувачів завдань» [3]; М. Мінський (автор моделі фрейма і фреймового подання знань) [7].

Приблизно у ті ж 50—60 рр. XX ст. розпочалося становлення ШІ і в колишній Українській Радянській республіці. Але, на відміну від західних дослідників, вітчизняні йшли від моделювання ігор, створення пристроїв сприйняття типу «персептрон» й інтелектуальних роботів (тобто від практики, експериментів), і лише в 1990-ті рр. XX ст. з’явилися їх теоретичні праці (наприклад [6]).

На різних семінарах і в пресі тривалий період обговорювалися проблеми: чи може машина мислити, чи можна створити електронний мозок, подібний до мозку людини, чому неможливий штучний інтелект тощо. Подібні дискусії тривали до 80-х рр. XX ст. [5].

У 1957 р. американський фізіолог Ф. Розенблатт запропонував модель зорового сприйняття й розпізнавання — перцептрон. Поява програми, здатної навчатися поняттям і розпізнавати об’єкти, які пред’являються, становило надзвичайний інтерес не тільки для фізіологів, а й для представників інших галузей знань і породило великий потік теоретичних та експериментальних досліджень.

Перцептрон або будь-яка програма, що імітує процес розпізнавання, працює в двох режимах: у режимі навчання і режимі розпізнавання. В режимі навчання хтось (людина, машина, робот або природа), що відіграє роль учителя, пред’являє машині об’єкти і про кожен з них повідомляє, до якого поняття (класу) він належить. За цими даними будується вирішальне правило, що є, по суті, формальним описом понять. У режимі розпізнавання машині пред’являються нові об’єкти (взагалі-то відмінні від раніше пред’явлених), і вона повинна їх класифікувати, по можливості, правильно.

Проблема навчання розпізнаванню тісно пов’язана з іншим інтелектуальним завданням — перекладом з однієї мови на другу, а також навчання машини мові. За досить формальної обробки й

20

Г.Ф. Іванченко

класифікації основних граматичних правил та прийомів користування словником можна створити цілком задовільний алгоритм для перекладу, скажімо наукового або ділового тексту. Для деяких мов такі системи було створено ще наприкінці 60-х років XX ст. Працюють над такими програмами вже давно, але до цілковитого успіху ще далеко. Є також програми, що забезпечують діалог людини і машини урізаною природною мовою.

Починаючи з 1960 р. XX ,ст. було розроблено низку програм, здатних знаходити доведення теорем в обчисленні предикатів першого порядку. Ці програми мають, за словами американського фахівця в галузі ШІ Дж. Маккатті, «здоровий глузд», тобто здатність робити дедуктивні висновки.

Паралельно в 60—70-ті рр. XX ст. розроблялися окремі програми і проводився пошук розв’язання задач логіки, доведення теорем. Такі дослідження проводилися в Києві (в Інституті кібернетики АН УРСР під керівництвом В. М. Глушкова) і деяких інших наукових центрах.

Останнім часом для узагальненого найменування систем штучного інтелекту дедалі більшого поширення набуває термін інтелектуальні системи.

У програмі К. Гріна й ін., що реалізовує систему запитання- відповідь, знання записуються мовою логіки ііредикатів у вигляді набору аксіом, а запитання машині формулюються як такі, що вимагають доведення теореми. Великий інтерес становить «інтелектуальна» програма американського математика Хао Ванга. Ця програма за три хвилини роботи ЕОМ вивела 220 відносно простих лем і теорем з фундаментальної математичної монографії, а потім видала докази ще 130 складніших теорем, частина яких ще не була виведена математиками.

1.2. Соціальні результати інтелектуалізації комп’ютерних технологій

Позитивні соціальні результати інтелектуалізації інформаційних технологій зрозумілі та загальновідомі. З наслідків, не дуже сприятливих для людини, найочевидніший ;— це поступове витіснення людей машинами і в процесі виробництва, і в управлінні суспільством. Подібні тенденції почали проявлятися ще задовго до початку

СИСТЕМИ ШТУЧНОГО ІНТЕЛЕКТУ

21

комп’ютерної доби. Що стосується майбутнього, то тут письменни- ки-фантасти малюють похмурі картини цілковитого захоплення влади комп’ютерами і навіть фізичного винищення людства.

Було запропоновано ряд принципів, орієнтованих на зменшення ризиків, пов’язаних з комп’ютеризацією та інтелектуалізацією. Найбільш відомими є принципи, сформульовані американським фантастом Айзеком Азімовим. Ось ці наведемо їх:

— комп’ютер або робот не повинен заподіяти шкоди людині;

— він повинен виконувати накази людини, якщо це не суперечить першому принципу;

— він повинен прагнути до самозбереження, якщо це не суперечить першим двом принципам.

Інша проблема — як ці, або подібні до них принципи втілювати в життя. Серед інших негативних аспектів інтелектуалізації можна відмітити те, що сучасні комп’ютерні технології полегшують виконання не тільки корисних справ, а й різних зловживань та комп’ютерних злочинів тощо.

Переходячи до проблеми співвідношення можливостей людини і кібернетичної машини стосовно відтворення останньою функції мислення, слід насамперед указати на один важливий висновок, до якого привели кібернетика та математична логіка. Він полягає в тому, що будь-яка суворо окреслена й математично описана — формалізована й алгоритмізована — галузь інтелектуальної діяльності людини в принципі може бути передана машині (теза Тюринга). Іншими словами, будь-який детермінований процес, сутність якого можна пояснити людині, потенційно здійснюваний машиною, якій надано необмежений час і яка має необмежену пам’ять. Однак треба відрізняти потенційну здійснюваність від здійснюваності за допомогою наявних засобів. Збігатися обидва ці види можуть тільки для надприродного інтелекту.

Постає принципове запитання: чи можна моделювати інтелектуальну діяльність, а якщо можна, то як це зробити? Існує дві точки зору.

1. Багато вчених не мають сумніву, що обчислювальні машини і роботи можуть у принципі мати всі основні риси інтелекту. Таким чином, на запитання, чи можуть обчислювальні машини або роботи мислити, вони дають позитивну відповідь (А.Тимо- фєєв, А. Тюрінг, І. Шкловський).

2. Друга точка зору протилежна першій. Деякі схиляються на користь негативної відповіді на запитання, чи може машина

22

Г.Ф. Іванченко

уподібнитися людині. Серед них і творець кібернетики Джон фон Нейман. Розглядаючи завдання машинного моделювання ней- ронних структур мозку, він висунув гіпотезу, що якщо система досягає певного ступеня складності, її опис не може бути простішим, ніж вона сама. «Немає сумніву в тім, — писав Нейман, — що окрему фазу будь-якої уявної форми поведінки можна «цілком і однозначно» описати за допомогою слів. Цей опис може бути довгим, однак завжди можливим». З ідей фон Неймана випливає, що проблема створення машинної програми, здатної вирішувати всі ті різноманітні завдання, що успішно вирішує людський мозок, надзвичайно важка, якщо не безнадійна.

Раніше проблема штучного інтелекту розглядалася як технічна, позв’язана з реалізацією на ЕОМ програм, що здатні виконувати деякі класи інтелектуальних операцій. Згодом, однак, з одного боку, помітно зменшився оптимізм щодо інтелектуальних можливостей ЕОМ, а з другого — стало зрозуміло, що штучний інтелект — це не просто вдало написана програма, його створення — надзвичайно складна міждисциплінарна проблема, що вимагає для свого вирішення об’єднаних зусиль психологів, математиків, лінгвістів тощо. Так, психологія повинна дати чітке визначення знання для використання його в комп’ютерних системах. Лінгвістика мала б пояснити, як працює мова, що є не тільки носієм знань, а й бере активну участь |у їхньому формуванні. Оскільки ні та, ні інша наука не 1 дали необхідних відповідей, відомий представник дисципліни штучного інтелекту Р. Шенк змушений був констатувати, що конструктори комп’ютерних систем мусять створювати свої лінгвістичні й психологічні теорії, аби домогтися ефективного вирішення своїх завдань.

У нинішній час намітилося два шляхи дослідження штучного інтелекту:

1) машинні способи розв’язання інтелектуальних задач повинні будуватися без суворого огляду на людину, знання про те, як вона вирішує ті чи інші завдання;

2) «біонічно мислячі» вчені сподіваються на спеціально конструйовані мережі штучних нейронів та інші аналоги конструкцій, властиві людині.

Відзначимо один метод дослідження штучного інтелекту. Із самого початку зародження науки штучного інтелекту було поширено переконання щодо принципової здатності комп’ютера до самостійного дослідження моделі, що зберігається в ньому, тобто

СИСТЕМИ ШТУЧНОГО ІНТЕЛЕКТУ

23

до самостійного навчання стратегії досягнення поставленої мети. Лише до 80-го року була усвідомлена значущість проблеми використання в інтелектуальних системах людських знань про дійсність. Але ще раніше почалися дослідження, пов’язані зі спробою формального опису і комп’ютерної реалізації інтелектуальних систем, що не обмежуються моделюванням дійсності або знаннями про дійсність, але спираються на схеми усвідомлення і самої дійсності, і її образів. Схеми ці засновані на чіткому математичному описі структур рефлексії.

Філософська традиція називає рефлексією думки про думку, тобто коли предметом думки виявляється не річ, але факт мислення. Рефлексія — думка суб’єкта про наявний у нього образ дійсності, тобто критичний образ цього образу, що припускає оцінку створюваних в уяві моделей. Класична парадигма штучного інтелекту ігнорує цю обставину і тому не цікавиться рефлексією.

З усього вищесказаного випливає висновок, що до розходження між потенційно здійсненним і фактично реалізованим треба додати розходження між фактично реалізованим і нереалізованим у доступному майбутньому. А межі між потенційно здійсненним і нездійсненним за допомогою автоматів відповідає теза кібернетики. Для тих, хто визнає матеріалістичне положення про те, що будь-який процес природи пізнаваний за допомогою розуму, теза про принципову можливість моделювання на ЕОМ будь- якого реального процесу, якщо він зрозуміло й однозначно описаний якоюсь мовою, — є природним висновком з логіко-матема- тичної теорії обчислювання. На запитання, де пролягає межа між реально здійсненним для кібернетики і реально неможливим (хоча й можливо потенційним), відповіді ми не знаємо.

Так само немає вичерпних відповідей на такі запитання: на якій сировині (інформації чи знаннях) працюють системи штучного інтелекту, і чи означає це, що такого роду системи повинні імітувати розумові процеси людини? Нарешті, чи можна передати машині розумові здібності людини подібно до того, як нині в людському організмі природне серце заміняють на штучне?

Є багато заперечень із приводу можливості моделювання життєвих процесів психіки і розуму, які можна умовно розбити на три типи.

1. Еволюційне заперечення. Мозок сучасної людини — це результат процесу еволюції, що тривав мільярди років. Робота не

24

Г.Ф. Іванченко

можна навчати тривалий час. Тому ніколи не з’являться інтелектуальні роботи.

Помилка такого міркування полягає в постулюванні того, що автоматична система може імітувати відповідну біологічну функцію (мислення, політ тощо) тільки копіюванням механізму й еволюційного шляху свого біологічного прототипу. Роботи ж починають навчатися вирішенню інтелектуальних завдань, уже маючи дуже високу початкову організацію, закладену в них людиною. «Еволюційний стаж» людини споконвічно вкладається в стаж роботів. Крім того, можливий шлях природного накопичення інформації «кібернетичним зародком» через досвід спілкування [7].

2. Соціальне заперечення, згідно з яким людина — «істота

соціаде>на», а мислення — функція не людини, а людства, що виникло в результаті колективної діяльності (соціального життя) людей; а робот — індивідуальний за своєю природою, отже, він не може мати інтелект [8]. Це заперечення містить ту саму помилку — постулат про одиничність шляху до мислення. Сказане вище зовсім не виключає того, що інтелект може розвитися в процесі індивідуального вирішення дедалі складніших інтелектуальних завдань. Крім того, зовсім не виключено створення «колективу роботів» для спільного вирішення задач (ремонт самих себе, створення нових роботів, нового програмного забезпечення тощо). '

3. Третій тип пов’язаний із сумнівом щодо можливості імітації за допомогою неживих елементів явища життя взагалі. Тобто створення, відтворення її сутності на будь-якій якісно іншій основі. Однак якщо виходити з функціонального визначення поняття життя, за О. А. Ляпуновим, як «высокоустойчивого состояния вещества, использующего для выработки сохраняющих реакций информацию, кодируемую состояниями отдельных молекул» [9], то й у цьому плані не бачиться жодних принципових ускладнень. Способи кодування інформації можуть бути різні, і не обов’язково ґрунтуватися на білковій основі. Те саме стосується й вищого рівня організації життя, рівня цивілізації.

Усі ці заперечення поєднує одна загальна думка — штучний інтелект обов’язково має походити на інтелект людини.

Теза, що часто висувається: те, що робить людина, то і так само має робити це машина — дуже спірна. Невипадково введено слово «штучний» у назву «штучний інтелект», тому не зовсім

СИСТЕМИ ШТУЧНОГО ІНТЕЛЕКТУ

25

зрозуміла вимога деяких учених, щоб машинний інтелект обов’язково був подібний до людського. По суті, немає вагомих підстав казати, що машинні моделі розуміння і використання знань повинні наближатися за характером і структурою до схеми сприйняття й переробки інформації людиною [10].

Треба зазначити, що словосполучення найменування «штучний інтелект» фактично має метафоричний характер. Творці систем класу ШІ (штучний інтелект) не керуються психологічними структурами, що властиві процесу людського мислення. Природний інтелект співставляють зі штучним тільки за результатами їхнього функціонування. Необхідно додати, що штучний інтелект на сьогоднішній день не може претендувати на яке-небудь зіставлення з поліфункціональністю й безмежними здібностями людського інтелекту. Але за окремими параметрами комп’ютерні системи здатні значно перевершувати відповідні можливості людини. Спираючись на це, В. П. Зінченко називає комп’ютер не штучним інтелектом, а інструментом інтелектуальної дії, що може істотно полегшити, прискорити, підвищити точність прийняття рішення [11]. Великі надії нині покладаються на нейро- комп’ютери, що значно збільшать можливості «штучного інтелекту» і, на думку фахівців, зрештою перевершать інтелект свого творця.

Але припустимо, що людина спромоглася створити інтелект, що перевищує свій власний. Що буде з людством? Яку роль відіграватиме людина? І чи потрібно в принципі створення штучного інтелекту? Інтелектуальна система цілком може мати свої бажання і поводитися не так, як нам хотілося б. Таким чином, постає проблема безпеки. Чи не вийде так, що, тільки-но електронний мозок досягне людського рівня, людство виконає свою історичну місію (на кшталт динозаврів) і не буде потрібне більш ані природі, ані Богові, ні просто доцільності?

Як відзначалося, зовсім не виключено створення «колективу роботів». Уже існує глобальна мережа Internet, що поєднує ЕОМ в одне велике «комп’ютерне співтовариство», за допомогою якої відбувається «спілкування» комп’ютерів. Цілком можливе створення в майбутньому і цивілізації штучного розуму — машинної цивілізації. Н. С. Кардашев визначив цивілізацію як «высокоустойчивое состояние вещества, способного собирать, абстрактно анализировать и использовать информацию для получения качественно новой информации об окружающем и самом себе, для са¬

26

Г.Ф. Іванчвнко

мосовершенствования возможностей получения новой информации и для выработки сохраняющих реакций; цивилизация обособляется объемом накопленной информации, программой функционирования и пространством для реализации этих функций» [12]. З цього погляду немає протиріч у можливості існування цивілізації іншої природи, окрім білкової.

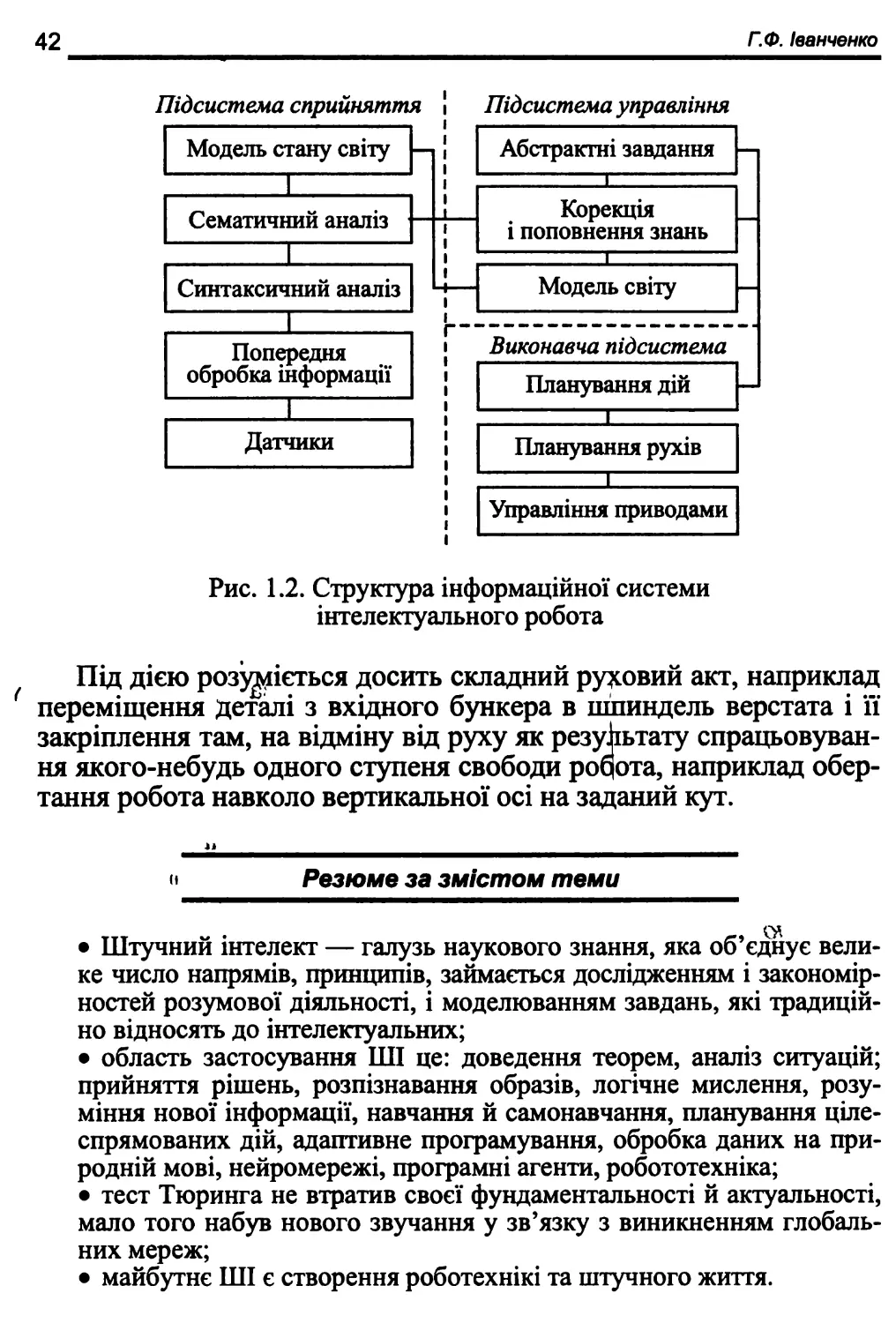

Машинна цивілізація — це не вигадка фантастів, а цілком обґрунтована реальність. Інша справа, чи хочемо ми її і чи так вона потрібна нам? Оскільки роботи в принципі можуть мати основні властивості біологічних систем, їх можна віднести і до «живих істот», якщо розуміти цей термін досить широко. Створюючи досконалих роботів, людина створює і нове життя — «життя роботів», високоорганізоване, але своєрідне і не схоже на наше життя. Зараз відбувається створення роботизованого «безлюдного» простору. Вважається, що роль людини в такому просторі зведеться тільки до складання програм, налагодження й ремонту устаткування. Ця тенденція вже спостерігається в розвинених країнах, де дедалі більше населення зайнято в цій сфері.

З розвитком техніки й створенням дедалі потужніших систем штучного інтелекту, коли вже і серце людини навчилися заміняти на природне, виникає питання про можливість «заміни» у майбутньому розуму людини на штучний. М. А. Берйяєв, наприклад, не бачив принципових труднощів у можливості впровадження техніки в органічне життя і навіть заміну його, але вважав це впровадження згубним для цивілізації [13]. У такому разі людина може перестати існувати як особистість, індивідуальність.

Під час створення штучного інтелекту вчені зіштовхнулися з низкою труднощів. Основні труднощі полягають у тому, що дотепер не існує однозначного і загальноприйнятого визначення й розуміння штучного інтелекту.

Так, А. В. Тимофеев пропонує називати інтелектом «здатність розуму вирішувати інтелектуальні задачі шляхом придбання, запам’ятовування і цілеспрямованого перетворення знань у процесі навчання на досвіді і адаптації до різноманітних обставин» [6]. Причому найважливішою відмінністю людського мислення є мова.

У філософії інтелект характеризує відносно стійку структуру розумових здібностей індивіда, що виявляються, наприклад, в умінні сприймати інформацію і використовувати її для розв’язання тих чи інших завдань.

СИСТЕМИ ШТУЧНОГО ІНТЕЛЕКТУ

27

Існують суто поведінкові визначення. За О. Н. Колмогоровим, будь-яка матеріальна система, що з нею можна досить тривалий час обговорювати проблеми науки, літератури і мистецтва, має інтелект. Іншим прикладом інтелекту може слугувати відоме визначення А. Тюринга [14], засноване на спеціально організованій «грі в імітацію» між людьми і машиною, що знаходяться в різних кімнатах, але мають можливість обмінюватися інформацією. Якщо в процесі діалогу між учасниками гри людям не вдається встановити, що один з учасників — машина, то таку машину можна вважати наділеною інтелектом. Недоліком Тюрингівського визначення інтелекту є те, що, на його думку, в принципі можна побудувати автомат з повним набором рішень всіх можливих задач — і удаваний інтелект зведеться до простого вибору в пам’яті відповідного рішення.

У найзагальнішому значенні штучний інтелект — це сукупність автоматичних методів і засобів цілеспрямованої переробки інформації відповідно до досвіду, що набувається в процесі навчання, й адаптації при вирішенні різноманітних задач [6]. Особливості тієї чи іншої системи штучного інтелекту визначаються властивостями закладених у неї алгоритмів і програм та технічною реалізацією.

Штучний інтелект — галузь наукового знання, яка об’єднує велике число напрямів, принципів, які відповідають дослідженням і закономірностям розумової діяльності, моделювання завдань, які традиційно належать до інтелектуальних.

Отже, проблема визначення штучного інтелекту зводиться до визначення інтелекту взагалі: чи є він чимось єдиним, чи цей термін об’єднує набір розрізнених здібностей? Якою мірою інтелект можна створювати?

На цей час у число напрямів ШІ включають від дослідження принципів сприйняття (моделювання органів зору, дотику тощо) і моделювання функцій мозку до спеціальних методів доведення теорем, діагностики захворювань, розпізнавання образів то мови, гри в шахи, написання віршів і музичних творів, казок тощо.

Теорія штучного інтелекту має досить тривалу передісторію. Ідея створення штучної людини для вирішення складних завдань і моделювання людського розуму виникла ще в стародавні часи.

У сучасному уявленні ШІ — «Науковий напрям, метою якого є розробка апаратно-програмних засобів, що дозволяють не програмісту ставити і вирішувати свої, що традиційно вважаються

28

Г.Ф. Іванчвнко

інтелектуальними, завдання, спілкуючись з ЕОМ на обмеженій підмножині природної мови» [14].

Таке визначення охоплює практично всі напрями діяльності в широкій галузі знань, яку називають штучний інтелект. І в такому трактуванні результати досліджень у галузі ШІ найцікавіші для систем, що розвиваються, і вирішення завдань системного аналізу.

З давніх давен людині були потрібні помічники для полегшення виконання тих чи тих операцій. Було винайдено різноманітні механізми, машини тощо. Поява електронно-обчислювальних машин дала змогу автоматизувати виконання трудомістких розрахункових робіт. Згодом стало зрозуміло, що ці машини можна використовувати не тільки для обчислень, а й для керування різними пристроями, складними автоматизованими виробництвами тощо. Широкого поширення набули роботи — програмно керовані пристрої, здатні безпосередньо взаємодіяти з фізичним Літом та виконувати в ньому певні дії. Такі роботи широко використовуються у виробництві. Вони можуть працювати і в умовах, які людина не в змозі витримати — на дні океану, всередині ядерного реактора тощо. Але такі помічники вимагають автоматизованого керування, тобто їм постійно потрібно «підказувати», що і як вони мають робити в певній ситуації. |

Природна мова на сучасному етапі малопридатна для цього через свою складність та неоднозначність. Одним із шляхів вирішення цього завдання є формулювання інструкцій мовою, зрозумілою виконавцю, тобто написання програм.

Ми знаємо про складності сучасного програмування, пов’язані з необхідністю надмірної алгоритмізації, тобто детального ретельного розписування інструкцій з урахуванням усіх можливих ситуацій. Тут єдиний вихід — підвищення рівня «розумності», інтелектуальності сучасних комп’ютерів та роботів. Постає запитання, що розуміємо під такими поняттями, як «інтелектуалізація», «штучний інтелект»?

Можна стверджувати, що штучний інтелект у тому чи іншому розумінні повинен наближатися до інтелекту природного і в ряді випадків використовуватися замість нього; так само, як, наприклад, штучні нирки працюють замість природних. Що більше буде ситуацій, коли штучні інтелектуальні системи зможуть замінити людей, тим більш інтелектуальними будуть вважатися ці системи.

СИСТЕМИ ШТУЧНОГО ІНТЕЛЕКТУ

29

Було зроблено чимало спроб дати формальне визначення поняття інтелекту, зокрема, штучного. Найвідомішим є визначення предмета теорії штучного інтелекту, яке було введене видатним дослідником у галузі штучного інтелекту Марвіном Мінським. Воно потрапило до багатьох словників та енциклопедій з невеликими змінами і відображає таку основну думку: «штучний інтелект є дисципліна, що вивчає можливість створення програм для вирішення завдань, які при вирішенні їх людиною потребують певних інтелектуальних зусиль». Але і це визначення має вади. Головна з них полягала в поганій формалізації поняття «певні інтелектуальні зусилля». «Певних інтелектуальних зусиль» вимагає, наприклад, виконання простих арифметичних операцій, але чи можна вважати інтелектуальною програму, яка здатна виконувати тільки такі операції? У ряді книг та енциклопедій до наведеного визначення додається поправка: «сюди не входять завдання, для яких відома процедура їх розв ’язання». Важко вважати таке формулювання задовільним. Розвиваючи цю думку далі, можна було б продовжити: отже, якщо я не знаю, як виконувати певне завдання, то вона є інтелектуальною, а якщо знаю — то ні. Наступний крок — це відомі слова Л.Теслера: «Штучний інтелект

— це те, чого ще не зроблено». Цей парадоксальний висновок лише підкреслює дискусійність проблеми.

Є деякі конструктивніші визначення інтелекту. Наприклад одне з них: «інтелект є здатність правильно реагувати на нову ситуацію». Там же наводиться й критика цього визначення: не завжди зрозуміло, що слід вважати новою ситуацією. Уявіть собі, наприклад, звичайний калькулятор. Цілком імовірно, що на ньому ніколи не обчислювали суму двох нулів. Тоді завдання «обчислити нуль плюс нуль» можна вважати ситуацією, новою для калькулятора. Безумовно, він з нею впорається («правильно від- реагує на нову ситуацію»), але чи можна на цій підставі вважати його інтелектуальною системою?

Ми в нашому підручнику інтелектом називатимемо здатність мозку вирішувати (інтелектуальні) завдання шляхом придбання, запам’ятовування і цілеспрямованого перетворення знань у процесі навчання на досвіді й адаптації до різноманітних обставин.

У цьому визначенні під терміном «знання» маємо на увазі не тільки у інформацію, яка надходить у мозок через органи чуття. Подібні знання надзвичайно важливі, але недостатні для інтелектуальної діяльності. Річ у тому, що об’єкти навколишнього сере¬

зо

Г.Ф. Іванчвнко

довища мають властивість не лише впливати на органи чуття, але й перебувати одне з одним у певних відносинах. Зрозуміло, що аби здійснювати в навколишньому середовищі інтелектуальну діяльність (або хоч би просто існувати), необхідно мати в системі знань модель цього світу. У цій інформаційній моделі навколишнього середовища реальні об’єкти, їх властивості і відносини між ними не тільки відображаються й запам’ятовуються, але й, як відмічено в цьому визначенні інтелекту, можуть у думках «цілеспрямовано перетворюватися». Суттєвим є те, що формування моделі зовнішнього середовища відбувається «в процесі навчання на досвіді й адаптації до різноманітних обставин».

1.3. Тест Тюринга та фактичний діалог

У 1950 році в статті «Обчислювальні машини і розум» (Computing machinery and intelligence) видатний англійський математик і філософ Алан Тюринг запропонував тест, щоб не виникало безглузде, на його думку, запитання чи «може машина мислити?».

Замість того, щоб відверто сперечатися про критерії, що дозволяють відрізнити живу мислячу істоту від машини, яка виглядає як жива і мисляча, він запропонував, як спосіб на практиці встановити це.

Суддя-людина обмежений час, наприклад 5 хвилин, переписується в чаті (у оригіналі — телеграфом) на природній мові з двома співбесідниками, один з них — людина, а другий — комп’ютер. Якщо суддя за наданий час не зможе надійно визначити, хто є хто, то комп’ютер пройшов тест.

Передбачається, що кожний із співрозмовників прагне, щоб людиною визнали його. З метою зробити тест простим і універсальним, листування зводиться до обміну текстовими повідомленнями.

Листування має проводитися через контрольовані проміжки часу, щоб суддя не міг зробити висновок виходячи із швидкості відповідей. (Тюринг ввів це правило тому, що в його часи комп’ютери реагували набагато повільніше за людину. Сьогодні навпаки, це правило необхідне, тому, що ЕОМ реагує набагато швидше, ніж людина).

Ідею Тюринга підтримав Джо Вайзенбаум, що написав у 1966 році першу програму, яка «розмовляє» — «Еліза». Програма

СИСТЕМИ ШТУЧНОГО ІНТЕЛЕКТУ

31

всього в 200 рядків лише повторювала фрази співбесідника у формі запитань і складала нові фрази з уже використаних у бесіді слів.

А. Тюринг вважав, що комп’ютери кінець кінцем пройдуть його тест, тобто на запитання, «чи може машина мислити?», він відповідав ствердно, але в майбутньому часі: «так, зможе!»

Алан Тюринг був не тільки видатним ученим, але й справжнім пророком комп’ютерної доби. Досить сказати, що в 1950 році він писав, що до 2000 року на столі у мільйонів людей стоятимуть комп’ютери, що мають оперативну пам’ять 1 мільярд біт (близько 119,2 Мб) і виявився в цьому абсолютно правий. На той час усі комп’ютери світу разом узяті навряд чи мали таку пам’ять. Він також передбачив, що навчання відіграватиме важливу роль у створенні потужних інтелектуальних систем, що сьогодні абсолютно очевидно для всіх фахівців з ШІ. Саме цей шлях і використовують практично всі системи ШІ. Крім того, на цьому шляху з’являються й інші ознаки інтелектуальної діяльності: накопичення досвіду, адаптація тощо.

Проти тесту Тюринга було висунуто кілька заперечень.

1. Машина, що пройшла тест, може не бути розумною, а просто дотримуватися певного хитромудрого набору правил.

На що Тюринг не без гумору відповідав: «А звідки ми знаємо, що людина, яка щиро вважає, що мислить, насправді не дотримується якогось хитромудрого набору правил?»

2. Машина може бути розумною і не уміючи розмовляти, як людина, адже не всі люди, яким не відмовити в розумі, вміють писати.

Можуть бути розроблені варіанти тесту Тюринга для неграмотних машин і суддів.

3. Якщо тест Тюринга й перевіряє наявність розуму, то він не перевіряє свідомість (consciousness) і вільний намір (intentionality), отже не вловлює вельми істотних відмінностей між розумними людьми і розумними машинами.

Сьогодні вже існують численні варіанти інтелектуальних систем, які не мають мети, але мають критерії поведінки: генетичні алгоритми й імітаційне моделювання еволюції. Поведінка цих систем має такий вигляд, неначе в них різна мета і домагаються її.

Щорічно проводяться змагання між програмами, що розмовляють і найбільш людиноподібним, на думку суддів, присуджується приз Лебнера (Loebner) у розмірі $ 100 000!

Існує також приз для програми, яка, на думку суддів, пройде тест Тюринга. Цей приз ще жодного разу не присуджувався.

32

Г.Ф. Іванченко

На останок відзначимо, що й сьогодні тест Тюринга не втратив своєї фундаментальності й актуальності, мало того — набув нового звучання у зв’язку з виникненням Internet, спілкуванням людей в чатах і на форумах під умовними ніками і появою поштових і інших програм-роботів агентів, які розсилають спам (некоректну нав’язливу рекламу й іншу незатребувану інформацію), зламують паролі систем і намагаються виступати від імені їх зареєстрованих користувачів, здійснюють інші неправомірні дії.

Таким чином сьогодні вже постає питання:

> розпізнавання, ідентифікації статі й інших параметрів співрозмовника;

> виявлення листів, написаних і відісланих не людьми, а також такого автоматичного написання листів, щоб відрізнити їх від написаних людьми було неможливо. Отже, антиспамовий фільтр на електронній пошті теж є щось на кшталт тесту Тюринга.

Подібні проблеми (ідентифікації: людина або програма) можуть виникнути і в чатах. Що заважає зробити мережевих роботів на зразок програми «Еліза», але значно більш розроблених, які самі реєструватимуться в чатах і форумах, братимуть участь у них з використанням слів і модифікованих пропозицій інших учасників? Простий варіант — дублювання з інших форумів і перенесення їх з форуму на форум без змін, що ми вже іноді спостерігаємо в Internet.

На практиці, щоб на вході системи визначити, хто в неї входить, людина або робот, досить при вході пред’явити простеньке для вирішення людиною, але таку що вимагає величезних обчислювальних ресурсів і системи, завдання розпізнавання випадкових наборів символів, представлених у нестандартних зображеннях, масштабах і поворотах на тлі шуму. Вирішив, отже стукається людина-корис- тувач, не вирішив — на вході робот-агент, що передається світовою мережею з невідомою, найчастіше непристойною метою.

1.4. Сучасні дослідження напряму штучного інтелекту

Однією з традиційних класифікацій напрямів досліджень у галузі штучного інтелекту є класифікація Ханта.

Перший напрАм має назву біологічний. У його основу покладено спроби вирішення інтелектуальних завдань шляхом безпосереднього моделювання психофізіологічних особливостей мозку

СИСТЕМИ ШТУЧНОГО ІНТЕЛЕКТУ

33

людини засобами електронно-обчислювальних машин. З часом стало зрозумілим, що розв’язати цю проблему в повному обсязі неможливо і недоцільно. Моделювання особливостей людського розуму в повному обсязі призведе до копіювання не тільки позитивних якостей, але й негативних. Стало зрозуміло, що таке моделювання хоч і має певне значення для створення штучного інтелекту, більше підходить для вивчення інтелекту природного. Таке вивчення оформилося у вигляді самостійної науки, яка отримала назву когнітивна психологія.

Інший підхід — прагматичний. Він майже не розглядає психофізіологічну діяльність людського мозку. Розвиваються підходи до вирішення інтелектуальних завдань незалежно від того, як співвідносяться ці підходи з тими процесами, що відбуваються в мозку людини.

Існує інша класифікація систем штучного інтелекту залежно від моделей та методів, що використовуються для вирішення практичних завдань. Ідеться про символьний та конекціоністсь- кий підходи. Ці підходи будуть детально розглянуті під час вивчення курсу; заразом можна відмітити, що символьний підхід орієнтований на моделювання процесів свідомого логічного мислення, а конещіоністський — підсвідомих рефлекторних процесів. Підходи можуть застосовуватися і окремо, і в комбінації. Найбільших успіхів можна досягти, лише комбінуючи ці підходи. Зрозуміло, що без використання рефлекторних методів жодну серйозну інтелектуальну проблему не можна розв’язати через «прокляття розмірності». Водночас, рефлекторні рішення не завжди правильні та оптимальні, і тому людина не може обійтися без логічного мислення, як не можуть без нього обійтись і системи штучного інтелекту.

Характерною особливістю сучасних досліджень є зближення та взаємопроникнення символьного та конекціоністського підходів. Галузі застосування ШІ:

• системи автоматизованого проектування кібернетичних та обчислювальних комплексів, інтелектуальних роботів;

• системи машинного перекладу, інформаційного пошуку, генерації документів, організації природного діалогу між користувачем і комп’ютером, оброблення та сприйняття природної мови та тексту;

• системи технічного зору, комп’ютерного бачення, розпізнавання зображень, мовних конструкцій, прийняття рішень, моде¬

34

Г.Ф. Іванчвнко

лювання інтелектуальних функцій поведінки, обробки нечисло- вих конструктивів;

• системи розпізнання та ідентифікації особи за біометричними показниками;

• системи ідентифікації комп’ютерного обладнання за унікальними показниками;

• системи захисту даних та контролю операцій з пластикови- ми банківськими картками;

• сучасні програмні системи моделей розуму, імітації інтелектуальної діяльності людини, бази знань;

• нейромережеві інтелектуальні системи для розв’язання нечітких і складних проблем, таких як розпізнавання геометричних фігур та кластеризація об’єктів;

• дорадчі економічні системи (ДЕС), системи автоматичного планування; системи передбачення прибутку та витрат; технологічного керування підприємства тощо;

• інтелектуальні системи управління житлом, які створені для контролю та автоматизації управління системами життєдіяльності будинку, такими як освітлення, водопостачання, вентиляція, кондиціювання, безпеки та пожежної сигналізації, що включають обладнання і програмне забезпечення для побудови цифрових систем відеоспостереження;

• інтелектуальні системи ГЕО, що надають клієнтам необхідні для бізнесу геоінформаційні продукти (наприклад комплект програм isgeoRegisterSS (isgeoRegister Software Suite) призначений для створення реєстраційних, кадастрових та інших інформаційних систем, у яких використовується зв’язок базової карти з тематичними даними);

• системи моделювання біологічних об’єктів засновані на ідеї генетичного підходу, що деякий алгоритм може стати ефективнішим, якщо відбере кращі характеристики у інших алгоритмів («батьків»);

• технологія інтелектуальних агентів в Інтернет. Відносно новий підхід, де ставиться задача створення автономної програми — агента, котрий співпрацює з навколишнім середовищем. А якщо належним чином примусити велику кількість «не дуже інтелектуальних» агентів співпрацювати разом, то можна отримати модель біологічного «мурашиного» інтелекту Swarm Intelligence (SI);

• цілий ряд прикладних систем впровадження в медичних та діагностичних комплексах, у проектуванні матеріалів з заданими

СИСТЕМИ ШТУЧНОГО ІНТЕЛЕКТУ

35

властивостями, програмуванні процесів хімічного синтезу, в технологіях збору і розповсюдження інформації, системи скринінг- діагностики здоров’я населення.

• ВСІ (Brain-Computer Interface). — системи, в яких викорис¬

товуються електричні, магнітні або гемодинамічні сигнали мозку для управління зовнішніми пристроями, такими як комп’ютери, перемикачі, управління транспортом, інвалідні коляски, побутові пристрої і нейропротези. >'

Уявно предметна область ШІ складається з реальних або абстрактних об’єктів — сутностей. Сутності предметної області знаходяться у визначених відношеннях (асоціаціях) одна до одної, які також можна розглядати як сутності і включати в предметну область. Між сутностями спостерігаються різні відношення подоби. Сукупність подібних сутностей складає клас сутностей, що є новою сутністю предметної області.

Для вирішення інтелектуальних задач необхідно використати знання з конкретної предметної області, подані в певній стандартній формі і створити програму їхньої обробки.

Класифікація проблемних середовищ ШІ може бути зроблена за такими вимірами:

• середовище, яке повністю або частково спостерігається;

• детерміноване або стохастичне середовище;

• епізодичне або послідовне середовище;

• статичне або динамічне середовище;

• дискретне або неперервне середовище;

• одноагентне середовище (коли в середовищі діє тільки один агент) або мультиагентне середовище (коли діють два агенти і більше).

Крім того, предметні області можна характеризувати такими аспектами: числом і складністю сутностей; їхніх атрибутів і значень атрибутів; зв’язністю сутностей та їхніх атрибутів; повнотою знань; точністю знань (знання точні або правдоподібні; правдоподібність знань подається певним числом або висловленням).

Задачі, що вирішуються інтелектуальними системами у проблемній області, класифікують:

• за ступенем зв’язності правил: зв’язні (задачі, що не вдається розбити на незалежні задачі) та малозв’язні (задачі, що вдається розбити на деяку кількість незалежних підзадач);

• з точки зору розробника: статичні (якщо процес вирішення задачі не змінює вихідні дані про поточний стан предметної об¬

36

Г.Ф. Іванчвнко

ласті) і динамічні (якщо процес вирішення задачі змінює вихідні дані про поточний стан предметної області);

• за класом вирішуваних задач:

1. Задачі розширення — задачі, у процесі вирішення яких здійснюється тільки збільшення інформації про предметну область, що не призводить ні до зміни раніше виведених даних, ані до вибору іншого стану області. Типовою задачею цього класу є задача класифікації.

2. Задачі довизначення — задачі з неповною або неточною інформацією про реальну предметну область, мета вирішення яких

— вибір з множини альтернативних поточних станів предметної області того, що є адекватний вихідним даним. У випадку неточних даних альтернативні поточні стани виникають як результат ненадійності даних і правил, що призводить до різноманіття різних доступних висновків з тих самих вихідних даних. У випадку неповних даних альтернативні стани є результатом довизначення області, тобто результатом припущень про можливі значення відсутніх даних. Дослідження учених в подальші роки напрямлено на ліквідацію розриву між згаданими вище напрямами. У 1994 p. Л. Заде ввів термін — «м’які обчислення» (soft computing). М’які обчислення це синтез методів (нечіткі системи + нейросистеми + генетичні алгоритми + імовірнісні обчислення (мережі довіри Байеса)).

3. Задачі перетворення — задачі, які здійснюють зміни вихідної або виведеної раніше інформації про предметну область, що є наслідком змін або реального світу, або його моделі.

Слід відмітити, що жодна з наявних систем штучного інтелекту, які працюють у перелічених галузях, не може реалізовувати зазначені вище функції інтелектуальної системи в достатньому обсязі. Тому про них краще казати як про інтелектуалізовані система, які мають деякі риси, що наближають їх до справді інтелектуальних систем.

1.5. Інтелектуальні роботи

Широким напрямом систем ШІ є роботехніка та штучне життя. У чому основна відмінність інтелекту робота від інтелекту універсальних обчислювальних машин?

Для відповіді на це запитання доречно пригадати вислів, що належить великому російському фізіологу І. М. Сеченову: «Вся нескінченна різноманітність зовнішніх проявів мозкової діяльно¬

СИСТЕМИ ШТУЧНОГО ІНТЕЛЕКТУ

37

сті зводиться остаточно лише до одного явища — м’язового руху». Іншими словами, вся інтелектуальна діяльність людини спрямована кінець кінцем на активну взаємодію із зовнішнім світом за допомогою рухів. Так само елементи інтелекту робота служать перш за все для організації його цілеспрямованих рухів. У той самий час основне призначення суто комп’ютерних систем ШІ полягає у вирішенні інтелектуальних завдань, що мають абстрактний або допоміжний характер, які зазвичай не пов’язані ані з сприйняттям навколишнього середовища за допомогою штучних органів чуття, ані з організацією рухів виконавчих механізмів.

Перші спроби моделювання таких сторін людської діяльності, що здаються людині дуже простими, зіткнулися із серйозними труднощами. (Наприклад, серйозною проблемою дотепер видається розпізнавання образів системами штучного інтелекту. Хоча, помітьмо, що проблеми розпізнавання текстів і перекладу, що вважалися раніше не менш серйозними, були частково розв’язані).

Треба відзначити, що останнім часом у сфері досліджень штучного інтелекту розвивається напрям, пов’язаний зі створенням нового класу пристроїв обчислювальної техніки — нейрокомп’ю- терів. Порівняно з традиційними універсальними ЕОМ, нейро- комп’ютери мають низку незвичайних властивостей, породжуваних їхньою архітектурою, що певною мірою відбиває динаміку інформаційних процесів головного мозку. Саме тому вони добре пристосовані до вирішення завдань розпізнавання образів [15].

Труднощі моделювання свідомості навіть на почуттєвому рівні пов’язані насамперед з цілісним, інтегративним характером її функціонування. Тому можна сказати, що діяльність свідомості має системний характер. Це має прояв, по-перше, у тім, що окремі форми почуттєвого пізнання виступають у взаємозв’язку і єдності; по-друге, їхня діяльність істотно залежить від мислення.

Проблема постала ще з часів Карела Чапека, який уперше використав термін «робот». Великий внесок в обговорення цієї проблематики зробили й інші письменники-фантасти. Як найві- доміші ми можемо згадати серії розповідей письменника- фантаста і вченого Айзека Азімова, а також досить свіжий твір Голівуда — «Термінатор». До речі, саме в Айзека Азімова ми можемо знайти ухвалене більшістю людей розв’язання проблеми безпеки. Йдеться про так звані три закони роботехніки.

1. Робот не може заподіяти шкоду людині або своєю бездіяльністю допустити, щоб людині було заподіяно шкоду.

38

Г.Ф. Іванчвнко

2. Робот має підкорятися командам, які йому дає людина, окрім тих випадків, коли ці команди суперечать першому закону.

3. Робот має піклуватися про свою безпеку тією мірою, якою це не суперечить першому і другому закону.

На перший погляд подібні закони, за їх цілковитого дотримання, мають забезпечити безпеку людства. Проте, якщо уважно розглянути, постають деякі питання. По-перше, закони сформульовано природною людською мовою, яка не припускає простого їх перекладу в алгоритмічну форму.

На відміну від деяких інших досягнень цивілізації, як-от автомобіль, літак, кухонна побутова техніка, штучний інтелект не має прототипів у народній творчості — міфах, легендах і казках. Міфи або мрії про нього виникають тільки з появою обчислювальної техніки й автоматики. Що стосується ранішньої міфології, найбільш близьким легендарним персонажем є штучна людина (андроїд або гомункулус). Проте він завжди присутній як бездумний слухняний господарю механізм. Можна пригадати залізну людину, яку виконував Гефесг на горі Олімп, дерев’яну людину, зроблену італійським майстром у Толедо і відому більше як Кам’яний гість О. С. Пушкіна, Голема—слугу середньовічного алхіміка з м. Праги.

Вони явилися прототипом сучасного робота. Проте, під час створення реальних сучасних роботів постава проблема спілкування з ними з метою формулювання їм завдань. Розв’язуючи цю проблему, ми почали розуміти, що якщо хочемо мати зручні й надійні засобі спілкування з роботом (або в загальному випадку з деякою складною системою), ми повинні забезпечити його засобами внутрішнього уявлення і вирішення завдань приблизно такими самими, як у людини. Інакше ми приречені абр вивчати штучну мову спілкування або програмування, або на «нерозуміння» роботом, що ми від нього хочемо.

Інтелектуальні роботи (іноді кажуть «інтелектні», або роботи зі штучним інтелектом) з’явилися з розвитком простих програмованих промислових роботів, у 60-ті роки. Тоді було закладено основи сучасних і майбутніх інтелектуальних роботів у дослідженнях, пов’язаних з координацією програмування роботів- маніпуляторів і технічного зору на основі телевізійної камери, планування поведінки мобільних роботів, спілкування з роботом на природній мові.

Експерименти з першими інтелектуальними роботами проводилися наприкінці 60-х — початку 70-х років у Стендфордському

СИСТЕМИ ШТУЧНОГО ІНТЕЛЕКТУ

39

університеті, Стендфордскому дослідницькому інституті (Каліфорнія), Массачусетському технологічному інституті (Массачусетс), Едінбурзькому університеті (Великобританія), в Електротехнічній лабораторії (Японія). Типовий інтелектуальний робот зовні схожий на людини, складається з однієї або двох механічних рук-захватів (маніпуляторів) і телевізійних камер, розміщених на рухомій частині системного блоку, сенсорів та мобільних літій-іонних батарей джерел живлення (рис. 1.1).

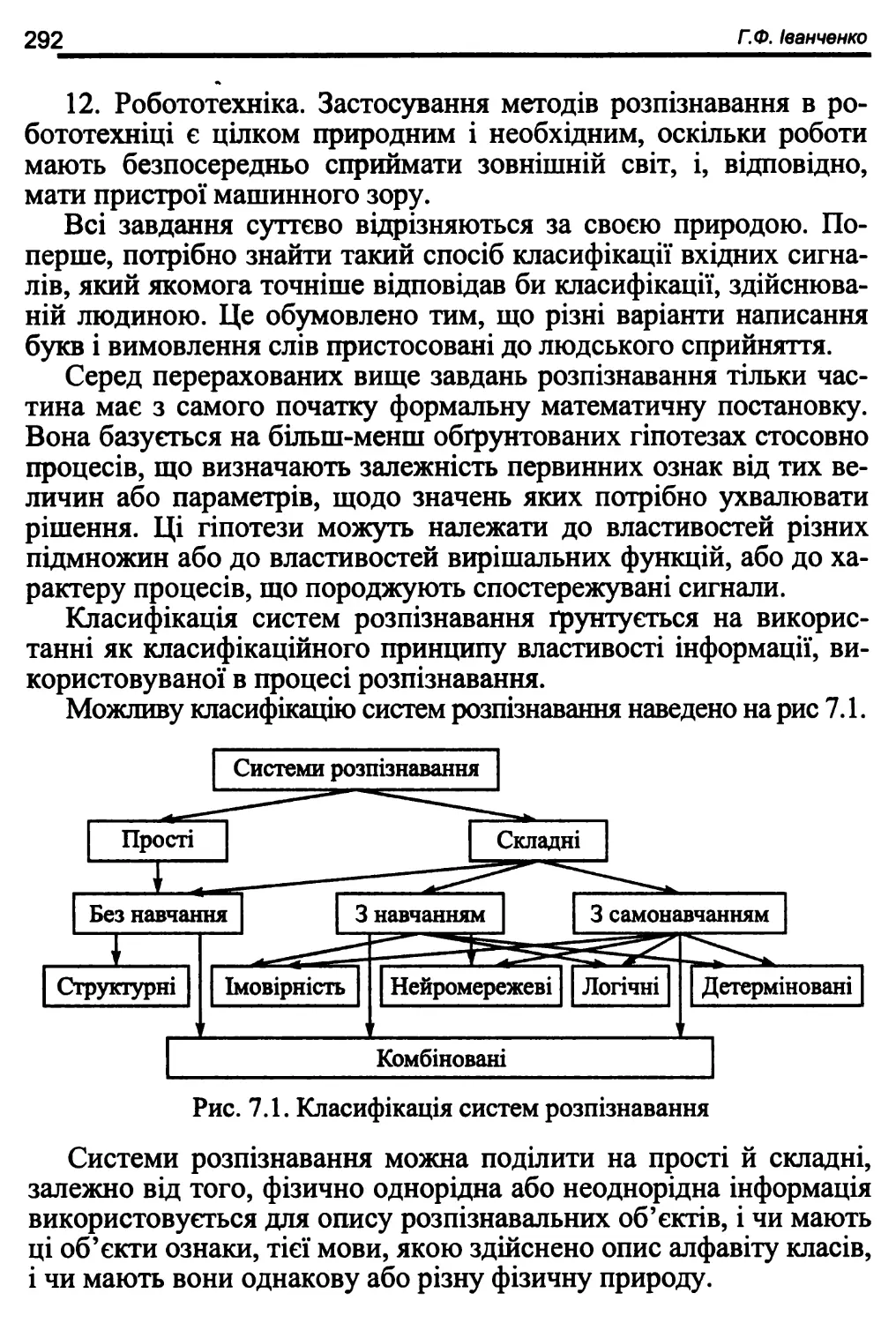

а) 6)