Текст

Alan George

University oj Waterloo

Waterloo, Ontario

Joseph W-H Liu

Computer

Solution

of Large Sparse

Positive

Definite

Systems

Prentice-Hall, Inc,

Englewood Cliffs,

New Jersey 07632

1981

А. Джордж

Дж.Лю

Численное

решение

больших

разреженных

систем

уравнений

Перевод с английского

X Д. Икрамова

Москва

«Мир»

1984

ББК 22.193

Д42

УДК 512.8 + 518.12

Джордж А, Лю Дж.

Д42 Численное решение больших разреженных систем урав-

уравнений: Пер. с англ. — М.: Мир, 1984. — 333 с, ил.

В книге известных американских математиков-вычислителей описаны все

основные методы решения разреженных положительно определенных линейных

систем Впервые в монографической литературе излагаются алгоритмы параллель-

параллельных и вложенных сечений, разработанные А Джорджем и предназначенные для

систем метода конечных элементов Включены тексты фортранных программ,

реализующие описанные методы

Для математнков-прикладников, для всех, кто связан с решением разрежен-

разреженных линейных систем, для студентов и аспирантов факультетов прикладной ма-

математики

1702070000-051

Д 041@1)—84 37~84' Ч> ' ББК 518

Редакция литературы по математическим наукам

ф 1981 by Prentice Hall, Inc., Englewood Cliffs, N.J,

© Перевод на русский язык, «Мир>, 1984

От переводчика

Книга американских математиков Джорджа и Лю посвящена

вопросам машинной реализации метода Холесского для решения

линейных систем с симметричными положительно определен-

определенными матрицами. Системы предполагаются разреженными; в то

же время, как правило, допускается использование только опе-

оперативной памяти. При таком серьезном ограничении повышение

порядка решаемых систем возможно лишь за счет максималь-

максимальной эксплуатации их разреженности.

Центральная проблема в методах исключения — это способ

выбора главных элементов. Для систем общего вида обычно

принимается компромисс между требованием численной устойчи-

устойчивости процесса и желанием по возможности сохранить разре-

разреженность матрицы. При этом использование разреженности

основывается исключительно на структуре матричного графа,

в то время как выбор по устойчивости зависит от числовых зна-

значений элементов. Отсюда следует, что для класса систем общего

вида с различными матрицами одинаковой структуры априор-

априорный выбор порядка исключения, вообще говоря, невозможен.

Иначе обстоит дело в симметричном положительно опреде-

определенном случае. Здесь численная устойчивость обеспечена при

любом порядке исключения, что позволяет подчинить выбор

главных элементов единственной цели — наиболее полному ис-

использованию разреженности.

В книге представлены — и реализованы в виде фортранных

подпрограмм — все основные современные подходы к обработке

разреженных структурно симметричных систем: методы, ориен-

ориентированные на уменьшение профиля; методы, основанные на

локальной минимизации заполнения (алгоритм минимальной

степени); блочные методы; -наконец, методы сечений для конеч-

ноэлементных систем. В каждый из названных методов, либо в

теоретическую разработку, либо в практическую реализацию,

авторы внесли собственный значительный вклад. В особенности

это относится к Алану Джорджу — одному из ведущих амери-

американских экспертов по разреженным матрицам. Имя Джорджа

известно советским специалистам главным образом в связи с

разработанным им оригинальным алгоритмом упорядочения

плоских конечноэлементарных графов. В нашей литературе этот

6 От переводчика

алгоритм обычно называют методом гнездовых или крестовых

сечений (разбиений). В предлагаемом переводе принят третий

вариант названия — алгоритм вложенных сечений Этим терми-

термином, по-видимому правильнее всего отражающим существо ме-

метода, я обязан В. Д. Чубаню

Книга адресована широкому кругу читателей — вычислителей

и инженеров, — занимающихся решением больших разреженных

систем. Она может составить основу спецкурса для студентов

факультетов прикладной математики. Для понимания мате-

материала достаточно скромной математической подготовки — зна-

знания вводного курса линейной алгебры и языка Фортран.

Можно сказать без преувеличения, что книга Джорджа и Лю

отражает самый передовой уровень математического обеспече-

обеспечения в данной области. Советскому читателю она принесет боль-

большую пользу.

X. Икрамов

Предисловие

Назначение этой книги — ввести читателя в важную практи-

практическую задачу машинного решения больших разреженных систем

линейных уравнений. У этой проблемы много граней —от фун-

фундаментальных вопросов, касающихся внутренней сложности не-

некоторых задач, до менее точно определенных вопросов, связан-

связанных с построением эффективных структур данных и составле-

составлением машинных программ. Чтобы ограничить объем книги и

при этом не пожертвовать подробностью изложения, мы решили

сузить ее предмет случаем симметричных положительно опреде-

определенных систем уравнений. Такие системы возникают очень часто

в различных областях науки и инженерных приложениях По

тем же причинам мы ограничиваемся разбором только одного

конкретного метода в рамках каждого общего подхода к реше-

решению больших разреженных положительно определенных систем.

Например, среди многих методов приближенной минимизации

ширины ленты матрицы мы выбрали лишь один, который в на-

нашей практике показал себя достаточно хорошо. Наша цель —

познакомить читателя с важнейшими идеями, а вовсе не предло-

предложить метод, который обязательно будет самым эффективным

для интересующей его конкретной задачи. Мы надеемся, что,

ознакомившись с книгой, читатель сможет вынести обоснован^

ные суждения относительно применимости и полезности изла-

излагаемых в ней идей и методов решения разреженных систем.

Характеристики алгоритмов для разреженных матриц могут

очень сильно зависеть от качества их машинной реализации;

сложность же реализации весьма различна для разных алго-

алгоритмов. Поэтому, хотя анализ алгоритмов для разреженных

матриц с помощью карандаша и бумаги полезен, он отнюдь не

достаточен. Мы считаем, что изучение и использование подпро-

подпрограмм, реализующих такие алгоритмы, является существенной

составной частью хорошего вводного курса в эту важную об-

область научных вычислений Исходя из этого, мы включили в

книгу листинги фортранных подпрограмм и их подробное обсуж-

обсуждение. В Приложении А описана процедура доводки подпро-

подпрограмм до состояния, при котором они полностью готовы к вводу

в машину.

Мы благодарны Мэри Уонг за превосходное качество пере-

перепечатки первоначального варианта рукописи, а Энн Трип де Рош

8 Предисловие

и Эзер Пант — за терпеливость при печатании многочисленных

переделок. Мы признательны также многим нашим студентам

за помощь в устранении ошибок, содержавшихся в ранних вер-

версиях книги. Особой благодарности засл>живают Хамза Рашваи

и Эсмонд Нг, тщательно проверившие ее окончательный вариант.

Написание книги заняло у нас много времени, которое иначе

принадлежало бы нашим женам и детям. Мы благодарим своих

жен за терпение и понимание и посвяшаем эту книгу им.

Алан Джордж

Джозеф Лю

/. Введение

§ 1.0. Об этой книге

В нашей книге речь идет об эффективных машинных методах

для решения больших разреженных систем линейных алгебраи-

алгебраических уравнений. Предполагается, чго читатель усвоил начала

линейной алгебры и знаком со стандартными матричными обо-

обозначениями и операциями. Полезно было бы и знакомство с тер-

терминологией теории графов, однако оно не является обязатель-

обязательным, поскольку все необходимые понятия и обозначения будут

введены там, где они нужны.

Это книга о вычислениях, и в ней содержится ряд фортран-

ных подпрограмм, предназначенных для изучения и использо-

использования. Поэтому читатель должен хотя бы в некоторой мере

владеть Фортраном, а в идеальном случае иметь доступ к вы-

вычислительной машине, с тем чтобы пропускать программы, ис-

использующие подпрограммы из этой книги. Успешность алгорит-

алгоритмов для разреженных матриц, возможно, более, чем в какой-

либо другой области вычислений, зависит от качества их

машинной реализации, т. е. машинной программы, исполняю-

исполняющей алгоритм. Реализация этих алгоритмов связана с использо-

использованием довольно сложных схем хранения, и степень сложности

весьма различна для разных алгоритмов. Некоторые алгоритмы,

очень привлекательные «на бумаге», совсем не таковы на прак-

практике вследствие усложненности и неэффективности их реализа-

реализации. Другие, теоретически не столь красивые алгоритмы могут

оказаться более практичными, поскольку их реализация проста

и требует лишь очень небольших «накладных расходов».

По этим и другим причинам, которые прояснятся позднее,

мы включили в книгу фортранные подпрограммы, реализующие

многие из обсуждаемых в ней алгоритмов. Мы приводим также

результаты некоторых численных экспериментов, иллюстрирую-

иллюстрирующие отмеченные выше проблемы реализации и дающие чита-

читателю некоторую информацию о времени и памяти, необходимых

для вычислений с разреженными матрицами на типовой ма-

машине. Подпрограммы были тщательно оттестированы; они напи-

написаны на машинно-независимом подмножестве Фортрана (Ryder

1974) и без каких-либо изменений они должны правильно рабо-

работать для большинства машинных систем. Они будут полезным

10 Г Л 1 Введение

дополнением к библиотеке любого вычислительного центра, вы-

выполняющего научные расчеты. У авторов можно пол>чшь запи-

записанные на ленту копии подпрограмм вместе с тестовыми зада-

задачами, обсуждаемыми и используемыми в главе 9.

Мы надеемся, что эта кнша будет полезна по крайней мере

в двух отношениях. Во-первых, она может служить учебником

для студентов-старшекурсников и аспирантов факультетов при-

прикладной и вычислительной математики, а также инженерных

специальностей. Упражнения в конце каждой главы имеют

целью проверку усвоения материала читателем, указание на-

направлений дальнейшего исследования и конкретных важных

задач. Некоторые упражнения требуют использования и/или

модификации составленных нами программ, поэтому желательно

иметь доступ к машине, оснащенной для работы на Фортране,

с необходимыми программами в библиотеке.

Книга должна послужить также полезным справочником для

научных работников и инженеров, которым приходится решать

задачи с большими положительно определенными матрицами.

Несмотря на специальность рассматриваемого класса задач,

существенная часть (а возможно, и большинство) линейных си-

систем, возникающих в научных и инженерных расчетах, обладает

этим свойством Это достаточно большой класс для того, чтобы

заслуживать отдельного рассмотрения. Вдобавок, как мы уви-

увидим позже, решение задач с большими, разреженными положи-

положительно определенными матрицами коренным образом отличается

от решения задач общего вида.

§ 1.1. Метод Холесского и проблема упорядочения

Все методы, обсуждаемые в книге, основаны на единствен-

единственном численном алгоритме, известном как метод Холесского, —

симметричном варианте гауссова исключения, скроенном для

симметричных положительно определенных матриц. Мы опре-

определим этот класс матриц и детально опишем метод в § 2.1.

Предположим, что система уравнений, которую нужно решить,

есть

Ах = Ь, A.1.1)

где А— N~X.N симметричная положительно определенная ма-

матрица коэффициентов, Ь — вектор длины N, называемый правой

частью, а х — вектор-решение длины N, компоненты которого

должно вычислить. Применение к А метода Холесского приво-

приводит к треугольному разложению

A = LLT, A.1.2)

1*де L — нижняя треугольная матрица с положительными диаго-

диагональными элементами. Матрица М называется нижней (верх-

§ 1.1 Метод Холесского и проблема упорядочения 11

ней) треугольной, если ¦ т,/ = 0 для i <C j (i > j). Верхний ин-

индекс Т указывает на операцию транспонирования. В § 2.1 мы

покажем, что разложение A.1.2) всегда существует, если А сим-

симметрична и положительно определена.

Подставляя A.1.2) в A.1.1), имеем

LLTx = b. A.1.3)

Замена у = Ux показывает, что х можно получить, решая тре-

треугольные системы

Ьу = Ь A.1.4)

и

LTx = y. A.1.5)

В качестве примера рассмотрим задачу

4

1

2

j_

2

2

1

2

0

0

0

2

0

3

0

0

2

0

0

0

2

0

0

0

16

' 1

Х\

х2

*3

*4

7

3

7

-4

-4

A.1.6)

Множитель Холесского для матрицы коэффициентов системы

A.1.6) выглядит так:

2

0.50

1

0.25

1

0.50

-1

-0.25

-1

1

-0.50

-2

0.50

-3

Решая систему Ly = Ь, получаем

3.5

2.5

6

-2.5

-0.50J

О

A.1.7)

12 Г л I Введение

Затем, решая систему Ux = у, находим

2

2

1

-8

-0.50,

Этот пример иллюстрирует наиболее важный факт, относя-

относящийся к применению метода Холесского для разреженной

матрицы А: матрица обычно претерпевает заполнение Это зна-

значит, что L имеет ненулевые элементы в позициях, где в нижней

треугольной части Д стояли нули.

Предположим теперь, что мы перенумеровали переменные в

соответствии с правилом x,-*-xs-t+\, /= 1, 2, ..., 5, и переупо-

переупорядочили уравнения так, чтобы последнее стало первым, второе

снизу — вторым сверху и так далее, пока, наконец, бывшее пер-

первое уравнение не станет последним. Мы получим тогда эквива-

эквивалентную систему уравнений П. 1.8)

16

0

0

0

2

0

5.

8

0

0

т

0

0

3

0

2

0

0

0

т

1

2

х

2

2

1

4

х

*з

х4

=

-4

-4

7

3

7

A.1.8)

Должно быть ясно, что эта перенумерация переменных и пере-

переупорядочение уравнений равносильны симметричной переста-

перестановке строк и столбцов Д, причем та же перестановка приме-

применяется к Ъ. Эту новую систему обозначим через Хх = }>. При-

Применяя к ней, как и прежде, метод Холесского, мы разложим Д

в произведение LU, где (с точностью до трех значащих цифр)

4 О

О 0.791

0 0 L.73

0 0 0 0.707

,0.500 0.632 1.15 1.41 0.129,

§ 1.1 Метод Холесского и проблема упорядочения 13

»»• * <

** » • *

» •• * *

• •* «в

* * * * *

• * * * *

• • **

• * * * t

• • •

• * •*

* * * *

• ***

**•

* •*

***

* *

* * *

* • •

* *

* *

***

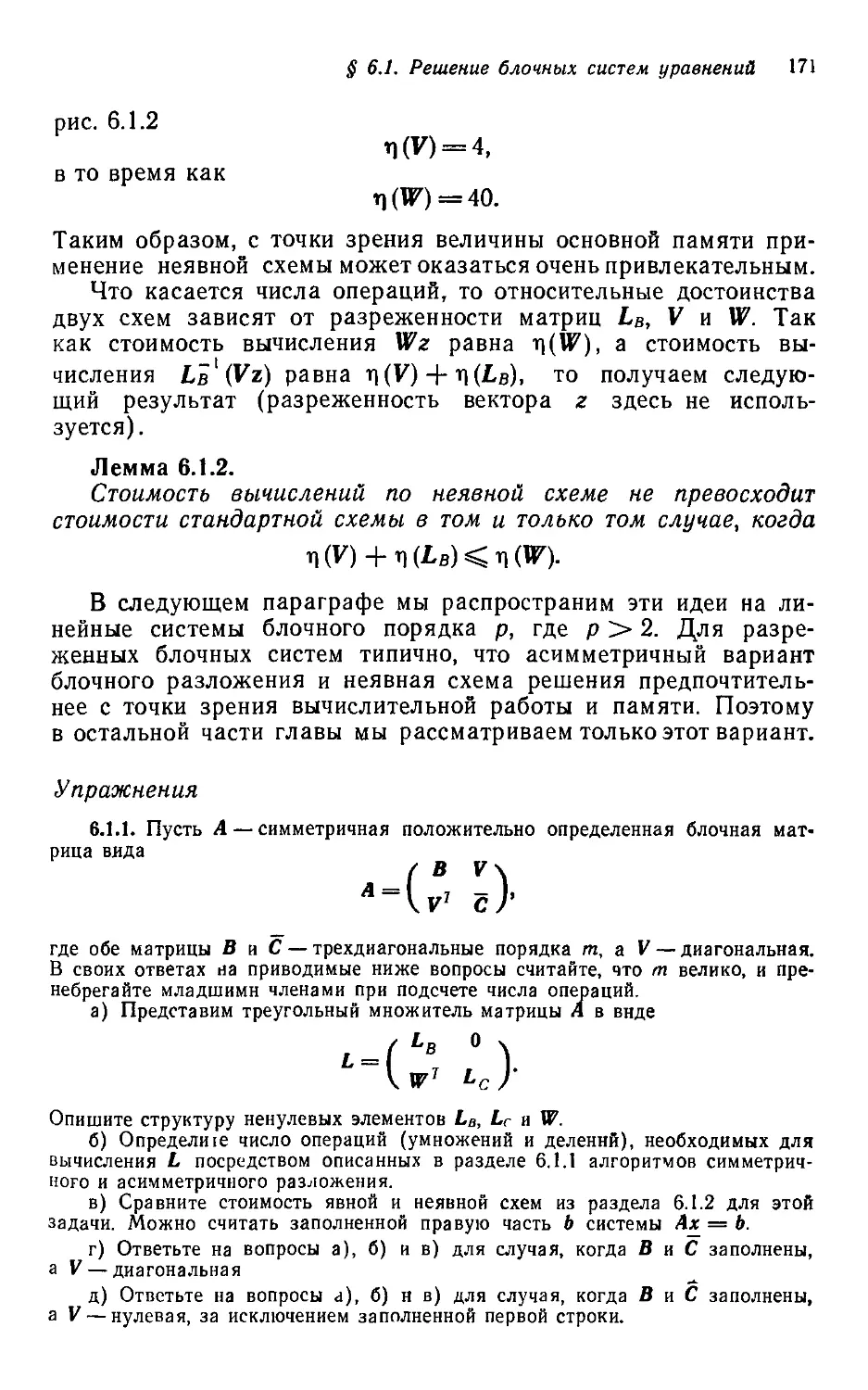

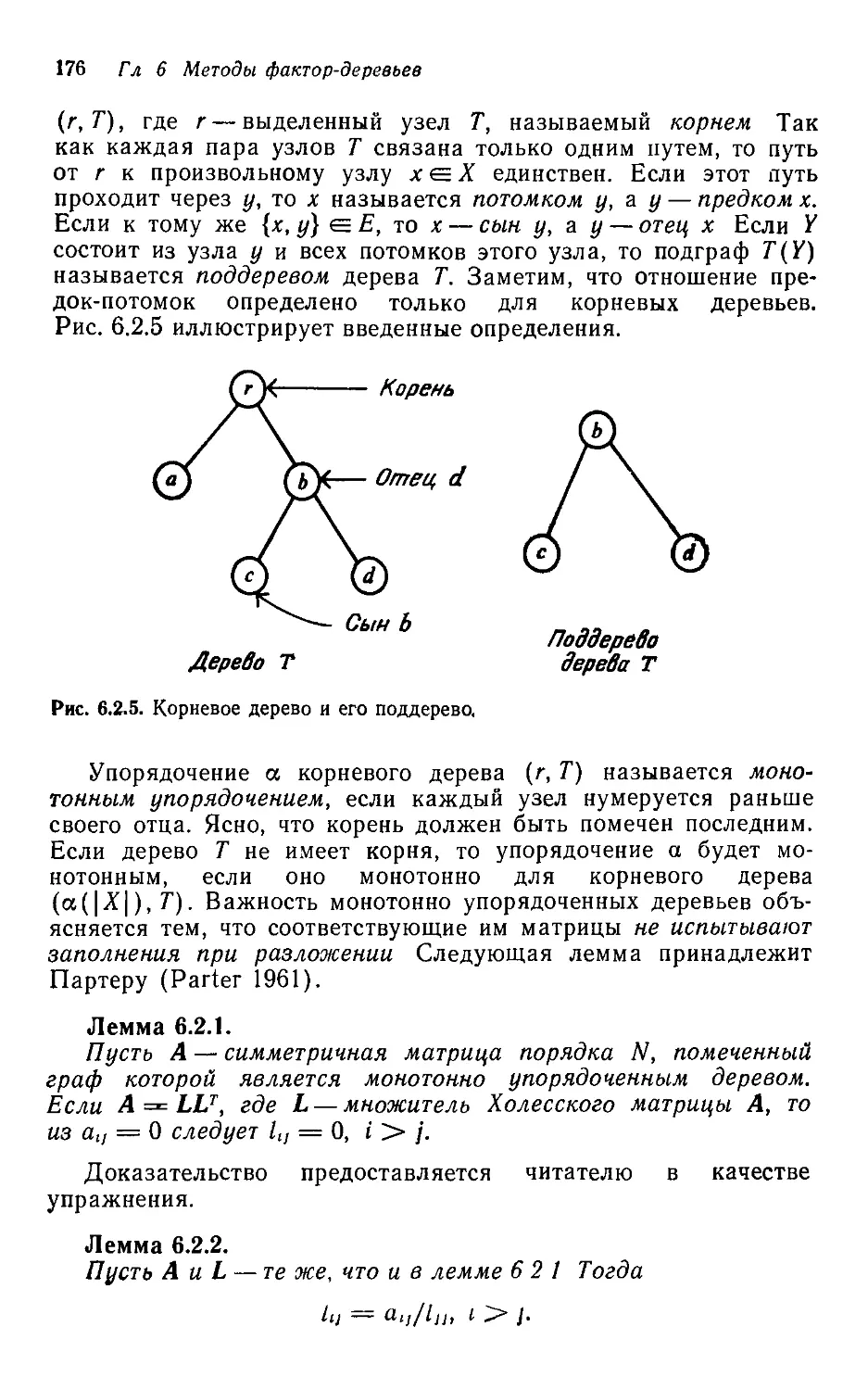

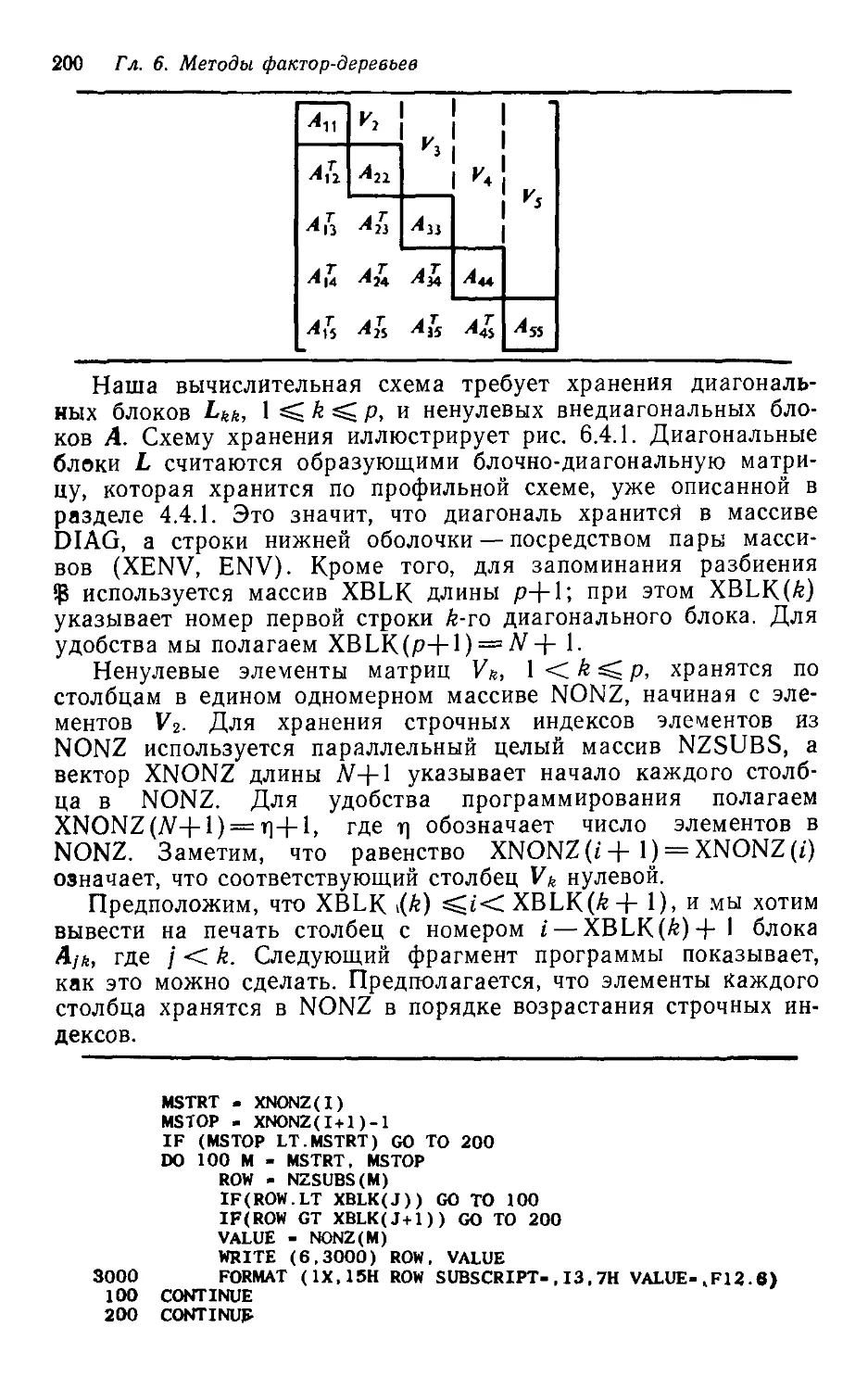

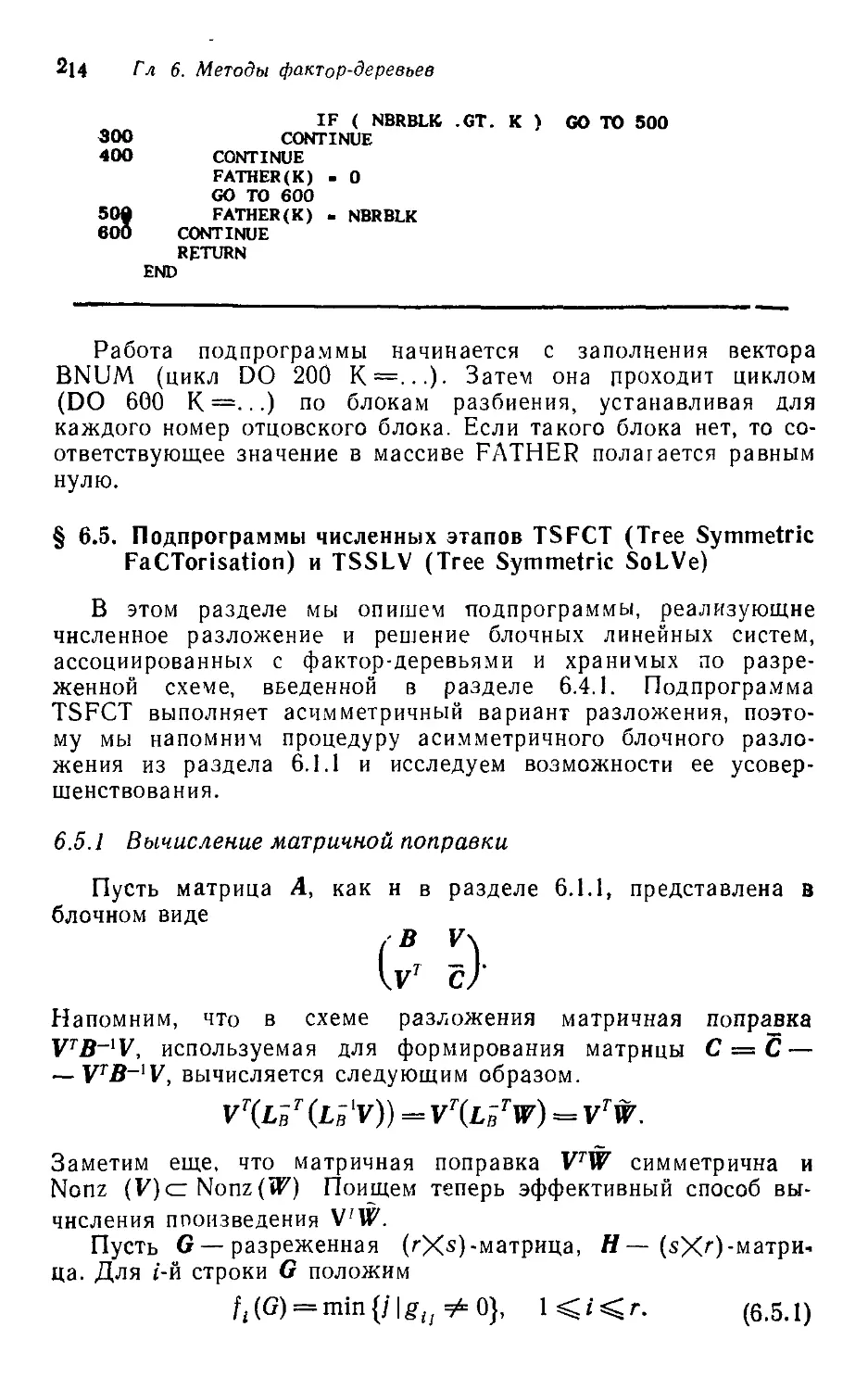

** *

Рис. 1.1.1. Структура ненулевых элементов матрицы Л порядка 35.

• * *

* *

*****

*****

**

Рис. 1.1.2. Структура ненулевых элементов множителя Холесского L для мат-

матрицы, устройство которой показано на рис. 1.1.1.

14 Гл 1 Введение

• • * *

• ф • •

ф ф ф *

* ф ф *

• • ф * •

• * • • •

ф ф ф ф *

• * ф *

* ф* *

* ф • • *

• ф ф • •

• ф • • ф

ф • •

> • * ¦ •

• • • • *

ф * ф ф ф

ф *• 4 *

• *ф •

ф •• ф ф

ф *** ф

ф • • ф •

• фф *

ф • ф ф

• ф ф • •

• • • ф •

* • * * •

• • Ф А

Ф * *

• • Ф Ф

Ф • • Ф

Ф * Л

Рис. 1.1.3. Структура матрицы А', симметричной перестановки

устройство которой показано на рис. 1.1.1.

матрицы Л,

* Ф • Ф

Ф Ф Ф

Ф Ф

Ml*

фффф ф ф

ф* фф

• фф

ф ф

* ф ф

• ф ф ф

Рис. 1.1.4. Структура L\ множителя Холесского матрицы А\ чье устройство

показано на рнс. 1.1.3.

§11. Метод Холесского и проблема упорядочения 15

Решая Ly = b и LTx = у, получим решение ж, которое есть

всего лишь переупорядоченная форма х. Важнейший момент

состоит в том, что переупорядочение уравнений и переменных

привело к треугольному множителю L, который разрежен в

точности в той мере, что и нижний треугольник А. Хотя на

практике редко удается достигнуть столь полного успеха, для

• *

* *

* * *

• • *

• *

• *

* • • •

* • • • •

* * * *

• * * *•

* • • • •

* • • • •

• • • * *

• • * • *

¦ * • •

* * •

* * * * *

* *

* * ••

> * * *

* * • * *

* •

* *

Рис. I.I.5. Структура матрицы 4", симметричной перестановки матрицы Л,

устройство которой показано на рис 1.1.1.

большинства задач с разреженными матрицами разумное упо-

упорядочение строк и столбцов матрицы коэффициентов может

дать огромное сокращение заполнения и, следовательно, эконо-

экономию машинного времени и памяти (при условии, конечно, что

разреженность используется). Исследование алгоритмов, кото-

которые автоматически выполняют этот процесс переупорядоче-

переупорядочения,— один из главных предметов этой книги наряду с иссле-

исследованием эффективных численны* методов и схем хранения

разреженных множителей L, предоставляемых этими переупо-

переупорядочениями.

Приведенный выше матричный пример 5X5 иллюстрирует

основные характеристики разреженного исключения и эффект пе-

переупорядочения. Чтобы лучше прочувствовать эти вопросы, рас-

рассмотрим пример несколько большего порядка; соответствующая

16 Га I Введение

ему структура нулей-ненулей приведена на рис. 1.1.1. Раскла-

Раскладывая эту матрицу в произведение LU, получим структуру!

указанную иа рис. 1.1.2. Очевидно, что матрица при ее тепереш-

теперешнем упорядочении нехороша для разреженного исключения, по-

поскольку она претерпевает значительное заполнение.

Рисунки 1.1.3 и 1.1.5 демонстрируют структуру двух сим-

симметричных перестановок А' и А" матрицы А, устройство которой

*

• •• *

• • *»*

** * ••••

• •• » *

• • * >•

• • * *

• * > >

** •• •*

* *

* •• ••• ** *

*•• *** *» **

**

Рве. 1.1.6. Структура L", множителя Холесского матрицы А", чье устройство

показано на рис. 1.1.5.

было показано на рис. 1.1.1. Матрица А' приведена к так назы-

называемой ленточной форме, обсуждаемой в главе 4. Матрица А"

упорядочена так, чтобы уменьшить заполнение; метод получе-

получения этого типа упорядочения является предметом главы 5.

Число ненулевых элементов в L, L' и L" равно соответственно

369, 189 и 177.

Как показывает наш пример, некоторые упорядочения могут

вести к весьма существенным сокращениям заполнения или

ограничить его определенными областями L, которые допускают

удобное хранение. Эта задача отыскания «хорошего» упорядо-

упорядочения, называемая в дальнейшем «проблемой упорядочения»,

занимает центральное место при решении разреженных подо-

жнтельно определенных систем.

$ 1.2. Положительно определенные задачи 17

§ 1.2. Положительно определенные и неопределенные матричные

задачи

В этой книге мы будем иметь дело исключительно со слу-

случаем, когда А симметрична и положительно определена. Как

уже было отмечено, существенная часть линейных систем, воз-

возникающих в научных и инженерных расчетах, обладает этим

свойством, и проблема упорядочения для них решается иначе

и проще, чем для разреженной матрицы А общего вида. В по-

последнем случае необходима для обеспечения численной устойчи-

устойчивости та или иная форма выбора главного элемента, т. е. пере-

перестановки строк и/или столбцов (Forsythe 1967). Таким образом,-

при заданной А обычно получают разложение для РА или PAQ,

где Р и Q —матрицы перестановок соответствующих размеров.

(Заметим, что умножение на Р слева переставляет строки 4, а

умножение на Q справа переставляет столбцы А.)

Эти перестановки определяются в процессе разложения пу-

путем компромисса между (обычно конкурирующими) требова-

требованиями численной устойчивости и разреженности (Duff 1974).

Различные матрицы, хотя бы они и имели одинаковую струк-

структуру нулей-ненулей, обычно приводят к различным Р и Q и,

следовательно, имеют множители с различной структурой раз-

.реженности. Другими словами, для разреженных матриц общего

вида, как правило, нельзя предсказать, где произойдет заполне-

заполнение, пока не начались собственно вычисления. Тем самым мы

вынуждены пользоваться какой-либо схемой динамического хра-

хранения, в которой память для заполнения выделяется в ходе вы-

вычислений.

С другой стороны, симметричное гауссово исключение (т. е.

метод Холесского или один из его вариантов, описываемых в

главе 2), в применении к симметричной положительно опреде-

определенной матрице, не требует перестановок (выбора главных эле-

элементов) для поддержания численной устойчивости. Поскольку

РАРТ также симметрична и положительно определена при лю-

любой матрице перестановки Р, это значит, что можно симметрич-

симметрично переупорядочить А, во-первых не заботясь о численной устой-

устойчивости и, во-вторых, до начала реального численного разло-

разложения.

Эти возможности, обычно отсутствующие в случае матрицы

А общего вида, имеют важнейшие практические последствия.

Раз упорядочение можно определить до начала разложения, то

можно определить также и местоположение заполнения, кото-

которое произойдет при разложении. Поэтому способ хранения L

можно выбрать до реального численного разложения, так же

как и зарезервировать место для элементов заполнения. Вычис-

Вычисления затем проводят при структуре хранения, остающейся ста-

статичной (неизменной). Таким образом, три задачи- 1) выбор

18 Гл. 1 Введение

надлежащего упорядочения; 2) формирование подходящей схемы

хранения; 3) реальные вычисления — могут быть разделены как

самостоятельные объекты исследования и как разные модули

программного обеспечения. Ситуация изображена на рисунке.

Найти

перестановку

Р

Сформировать

структуру

данных для L, где

РАРТ = LLT

Выполнить

вычисления

Эта независимость задач имеет ряд отчетливых преиму-

преимуществ. Она поощряет модульность при составлении математ»-

ческого обеспечения и, в частности, позволяет кроить метод

хранения по мерке данного этапа. Например, применение спи-

списков для хранения матричных индексов может быть вполне

приемлемо при реализации алгоритма упорядочения, но реши-

решительно неудобно для реального хранения матрицы или ее мно-

множителей. Точно так же уверенность в возможности использовать

при факторизации статичную схему хранения позволяет выбрать

метод, очень эффективный в смысле требований к памяти, ко-

который, однако, потребовал бы катастрофических накладных рас-

расходов, если бы схему хранения пришлось менять в процессе

разложения. Наконец, во многих инженерно-конструкторских

приложениях приходится решать большое количество различных

задач с положительно определенными матрицами, имеющих

одинаковую структуру. Ясно, что упорядочение и формирование

схемы хранения нужно выполнить лишь однажды; поэтому же-

желательно, чтобы эти этапы были изолированы от реальных вы-

вычислений.

В многочисленных практических ситуациях возникают ма-

матричные задачи, хотя и несимметричные, но имеющие симме-

симметричную структуру; при этом можно показать, что применение

к ним гауссова исключения не требует выбора главных элемен-

элементов для обеспечения численной устойчивости. Почти все идеи

и алгоритмы, описываемые в книге, непосредственно приложимы

к этому классу задач. Некоторые указания на то, как это можно

сделать, даны в упр. 4.5.1 главы 4.

§ 1.3. Итерационные и прямые методы

Численные методы для решения систем линейных уравнений

распадаются на два больших класса: итерационные и прямые.

Типичный итерационный метод состоит из выбора начального

§ 1.3. Итерационные и прямые методы 19

приближения *A> к х и построения последовательности *B),

жC), ..., такой, что lim x{t) = х. Обычно для вычисления х('+1)

нужны лишь Л, b и одно или два предыдущих приближения.

В теории при использовании итерационного метода мы должны

выполнить бесконечное число арифметических операций, чтобы

получить х, но на практике мы прекращаем итерацию, когда,

с нашей точки зрения, очередное приближение достаточно близ-

близко к х С другой стороны, при отсутствии ошибок округления

прямые методы позволяют вычислить решение за конечное число

арифметических операций.

Какой класс методов лучше? На этот вопрос нельзя ответить

безусловно; ответ зависит от того, какой смысл мы вкладываем

в слово «лучше», а также от конкретной решаемой задачи или

класса задач. Итерационные методы привлекательны с точки

зрения требований к машинной памяти, поскольку их реализа-

реализация в типичном случае требует хранения лишь Л, Ь, ж"' и еще,

может быть, одного или двух векторов. В то же время при раз-

разложении матрицы Л она обычно претерпевает некоторое запол-

заполнение, так что матрица заполнения1) F = L -\- U имеет нену-

ненулевые элементы в тех позициях, где в А стояли нули. Поэтому

реализация прямых методов часто требует большей памяти, чем

реализация итерационных. Реальное отношение очень сильно

зависит от решаемой задачи и от используемого упорядочения.

Сравнение прямых и итерационных методов с точки зрения

вычислительной работы еще более затруднено. Как мы видели,

выбор упорядочения в огромной степени влияет на количество

арифметической работы при использовании гауссова исключе-

исключения. Число итераций, выполняемых итерационной схемой, сильно

зависит от характеристик Л и от подчас деликатной проблемы

регистрации, посредством вычисляемых величин, момента, когда

х<'> «достаточно близок» к х.

В некоторых ситуациях, например, при конструировании не-

некоего механического устройства или моделировании какого-ни-

какого-нибудь разворачивающегося во времени явления приходится

решать много систем уравнений с одной и той же матрицей

коэффициентов. В этом случае стоимость прямой схемы может

по существу совпадать со стоимостью решения треугольной си-

системы при известном разложении, поскольку стоимостью един-

единственного разложения, отнесенного ко всем системам, можно

пренебречь В этих ситуациях часто верно и то, что число ите-

итераций, требуемых итерационной схемой, очень невелико, по-

поскольку имеются хорошие начальные векторы хA).

После этих замечаний должно быть ясно, что пока вопрос

о том, какой класс методов следует использовать, не поставлен

1) В оригинале — the filled matrix — Прим. перев.

20 Гл 1 Введение

в очень узком и хорошо определенном контексте, ответ на него

или слишком сложен или вообще невозможен. Причина, почему

в этой книге рассматриваются лишь прямые методы, та, что по

итерационным методам уже имеется несколько отличных спра-

справочных книг (Varga 1962, Young 1971); в то же время авторам

не известна сравнимая книга по прямым методам для больших

разреженных систем. Вдобавок существуют ситуации, когда

можно очень убедительно показать, что прямые методы намного

предпочтительней, чем любая мыслимая итерационная схема.

2, Вводные сведения

§ 2.0. Введение

В этой главе мы исследуем основной численный алгоритм,

используемый во всей книге для решения симметричных поло-

положительно определенных матричных задач. Этот метод, извест-

известный как метод Холесского, кратко обсуждался в § 1.1 Ниже

мы докажем, что для положительно определенных матриц раз-

разложение всегда существует, и изучим несколько способов, кото-

которыми могут быть организованы вычисления Хотя математически

и (обычно) численно эти способы эквивалентны, они разли-

различаются порядком, в котором вычисляются и используются

коэффициенты. Эти различия важны при машинной реализации

метода. Будут выведены также выражения для числа арифмети-

арифметических операций, требуемых методом.

Как было указано в § 1.1, при применении метода Холесского

к разреженной матрице А она обычно претерпевает некоторое

заполнение, так что множитель Холесского L имеет ненулевые

элементы в позициях, где в А стояли нули. При некоторой

матрице перестановки Р мы можем вместо А разложить в про-

произведение LU матрицу РАРТ, и в соответствии с тем или иным

критерием L может оказаться много привлекательнее, чем L

В § 2.3 мы обсуждаем некоторые из этих критериев и показы-

показываем, как факторы, обусловленные практической реализацией,

усложняют сравнение различных методов.

2.0.1. Обозначения

Предполагается, что читатель знаком с элементарной тео-

теорией и свойствами матриц; см., например, {Stewart 1973). В этом

параграфе мы опишем матричные обозначения, используемые

в книге.

Для обозначения матриц используются жирный курсив и про-

прописные буквы. Элементы матрицы обозначаются курсивными

строчными буквами с двумя индексами. Например, пусть

А — Л/Х iV-матрица. Ее элемент (i, /) обозначается через а,/.

Число N называется порядком матрицы А.

22 Гл. 2 Вводные сведения

Вектор обозначается жирной строчной буквой, а его компо-

компоненты — строчными буквами с одним индексом. Например,

v =

— вектор длины N.

Для данной матрицы А ее t-я строка и г-й столбец обозна-

обозначаются через А(» и А*< соответственно. Если А симметрична, то

Аи = А*, для i = 1, ..., N.

Для единичной матрицы порядка N, т. е. для матрицы, у ко-

которой на диагонали стоят единицы, а вне диагонали — нули,

используется обозначение In-

В анализе разреженных матриц часто приходится подсчиты-

подсчитывать число ненулевых элементов вектора или матрицы. Мы

пользуемся символом *](?) для числа ненулевых коэффициентов

в Q, где символ П замещает название вектора или матрицы.

Очевидно,

Часто приходится упоминать о числе элементов в множестве 5;

это число обозначается через \S\.

Пусть f(n) и g(n)—функции независимого переменного п.

Будем писать

если для некоторой константы К и всех достаточно больших п

\ш\<к-

Мы скажем, что f(n) есть, самое большее, величина порядка

g(n). Это полезное обозначение в анализе разреженных матрич-

матричных алгоритмов, поскольку часто интерес представляют лишь

доминирующие члены в оценках арифметики и количества не-

ненулевых элементов.

112

Например, если / (п) — -г п3 + -^ п2 — у п, то можно написать

Для достаточно больших п относительный вклад членов уп2

и (~тп) несуществен.

Выражения типа выписанной выше f(n) возникают при под-

подсчете числа арифметических операций или количества ненуле-

§ 2.1. Алгоритм разложения 23

вых элементов и являются часто результатом довольно слож-

сложных суммирозалнй. Поскольку обычно мы интересуемся лишь

главным членом, то очень распространенный прием упрощения

таких подсчетов состоит в замене знака суммы на символ инте-

интеграла. Например, для больших п

п

Bn + k) (n — k) ~ ^ Bn + k) (n — k) dk.

k-i о

Упражнения

N

2.0.1. Вычислить непосредственно сумму V i2 (N — i), а затем найти ее

1-х

приближенное значение, используя интеграл, как указано в конце параграфа.

2.0.2. Вычислить непосредственно сумму

N JV-i+1

а затем с помощью двойного интеграла приближенное значение.

2.0.3. Пусть А и В — разреженные матрицы порядка N. Показать, что

число умножений, необходимых при вычислении С = АВ1), равно

N

2.0.4. Пусть S — разреженная М X ^-матрица. Показать, что для вычис-

вычисления ВТВ достаточно

I M

умножений.

2.0.5. Обычная схема хранения разреженного вектора такова' имеются

основной массив, содержащий значения всех ненулевых компонент вектора, и

вспомогательный массив, хранящий индексы этих компонент. Пусть и и v —

два разреженных вектора порядка N, хранимых таким образом Рассмотреть

задачу вычисления скалярного произведения w = uTv.

а) Если индексные векторы упорядочены по возрастанию (или убыва-

убыванию), показать, что для вычисления скалярного произведения достаточно вы-

выполнить О(т](и) +r)(t>)) сравнений

б) А если индексы размещены случайным образом'

в) Как бы вы организовали вычисления, если бы индексы были разме-

размещены случайно, но у вас в распоряжении находился рабочий вещественный

массив длины N с нулевыми компонентами?

§ 2.1. Алгоритм разложения

2.1.1. Существование и единственность разложения

Симметричная матрица А называется положительно опре-

определенной, если хтАх > 0 для всех ненулевых векторов х. Такие

') В соответствии с определением произведения матриц — Прим перев.

24 Гл. 2. Вводные сведения

матрицы появляются во многих приложениях; в типичном слу-

случае произведение хтАх представляет энергию некоторой физи-

физической системы, которая положительна для любой конфигура-

конфигурации х. В положительно определенной матрице А диагональные

элементы всегда положительны, поскольку

где е — г-й характеристический вектор, все компоненты которого

равны нулю, кроме j'-й, равной единице. Это обстоятельство бу-

будет использовано в доказательстве следующей, теоремы о раз-

разложении, принадлежащей Холесскому (Stewart 1973).

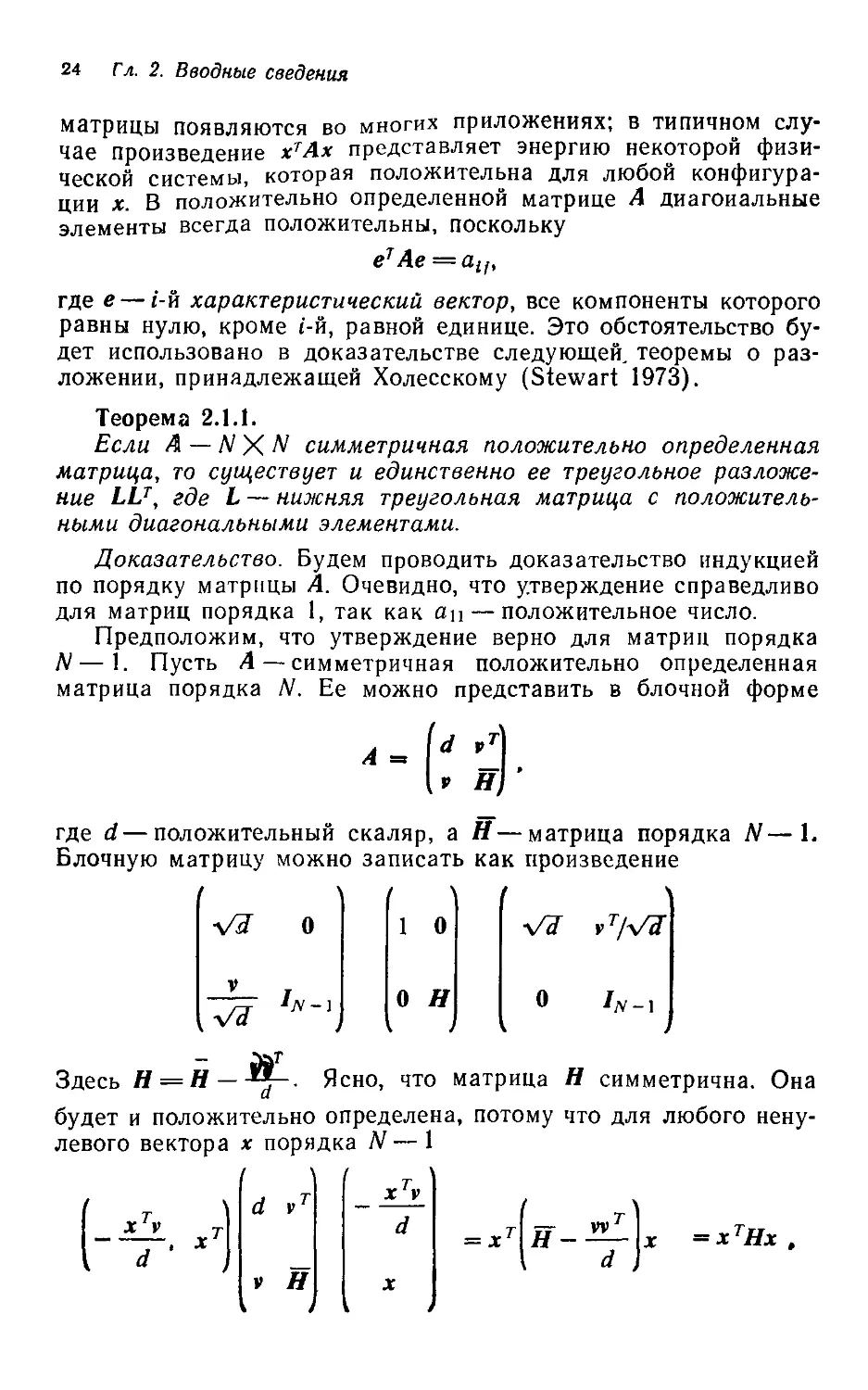

Теорема 2.1.1.

Если А — N X N симметричная положительно определенная

матрица, то существует и единственно ее треугольное разложе-

разложение LLT, где L — нижняя треугольная матрица с положитель-

положительными диагональными элементами.

Доказательство. Будем проводить доказательство индукцией

по порядку матрицы А. Очевидно, что утверждение справедливо

для матриц порядка 1, так как ац — положительное число.

Предположим, что утверждение верно для матриц порядка

N — 1. Пусть А — симметричная положительно определенная

матрица порядка N. Ее можно представить в блочной форме

—1.

где d — положительный скаляр, а Н — матрица порядка

Блочную матрицу можно записать как произведение

Vd~

1 О

О Н

о

Здесь Н = Н — j-- Ясно, что матрица Н симметрична. Она

будет и положительно определена, потому что для любого нену-

ненулевого вектора х порядка N— 1

ХТУ

d '

d vT

v H

1 xTv

d

X

L J

=xtHx.

§2.1 Алгоритм разложения 25

откуда следует хтНх > 0. По предположению индукции, Н имеет

треугольное разложение LhLh, причем диагональ Lh положи-

положительна. Поэтому А может быть разложена в произведение

0

Vet

VJ 0

1

0

0

LH

i

1

0

0

lS

A

-1

о

LLT-

Доказательство единственности множителя

читателю.

Применяя результат теоремы к матрице

'4 8

получим множители

представляется

/

\

/2 0W2 4N

V4 зДо зл

Здесь уместно отметить, что существует другое разложение

симметричной положительно определенной матрицы, тесно свя-

связанное с рассмотренным (Martin 1971). Поскольку множ-итель

Холесского имеет положительные диагональные элементы, то

можно вычленить из L диагональную матрицу DI/2, что дает

L = tD{'2 и

A = LDLT B.1.1)

В рассмотренном выше примере это разложение таково:

/1 0W4 04/1 24

V2 1 ДО 9 ДО 1/

Такое разложение столь же легко получить, как и первоначаль-

первоначальное, и при этом не потребуется извлекать квадратные корни

(см. упр. 2 1.4). Мы не используем его п этой книге, потому что

при некоторых обстоятельствах оно приводит к неприятной

асимметрии в вычислениях с блочными матрицами

2.1.2. Вычисление разложения

Теорема 2.1.1 гарантирует существование и единственность

множителя Холесского для симметричной положительно опреде-

определенной матрицы, однако порядок и способ реального вычисле-

вычисления элементов множителя L могут быть различными. В этом

26 Гл. 2. Вводные сведения

параграфе мы исследуем некоторые возможные методы вычис-

вычисления L. Наличие разных вариантов дает необходимую гибкость

при выборе схемы хранения разреженного матричного множи-

множителя L

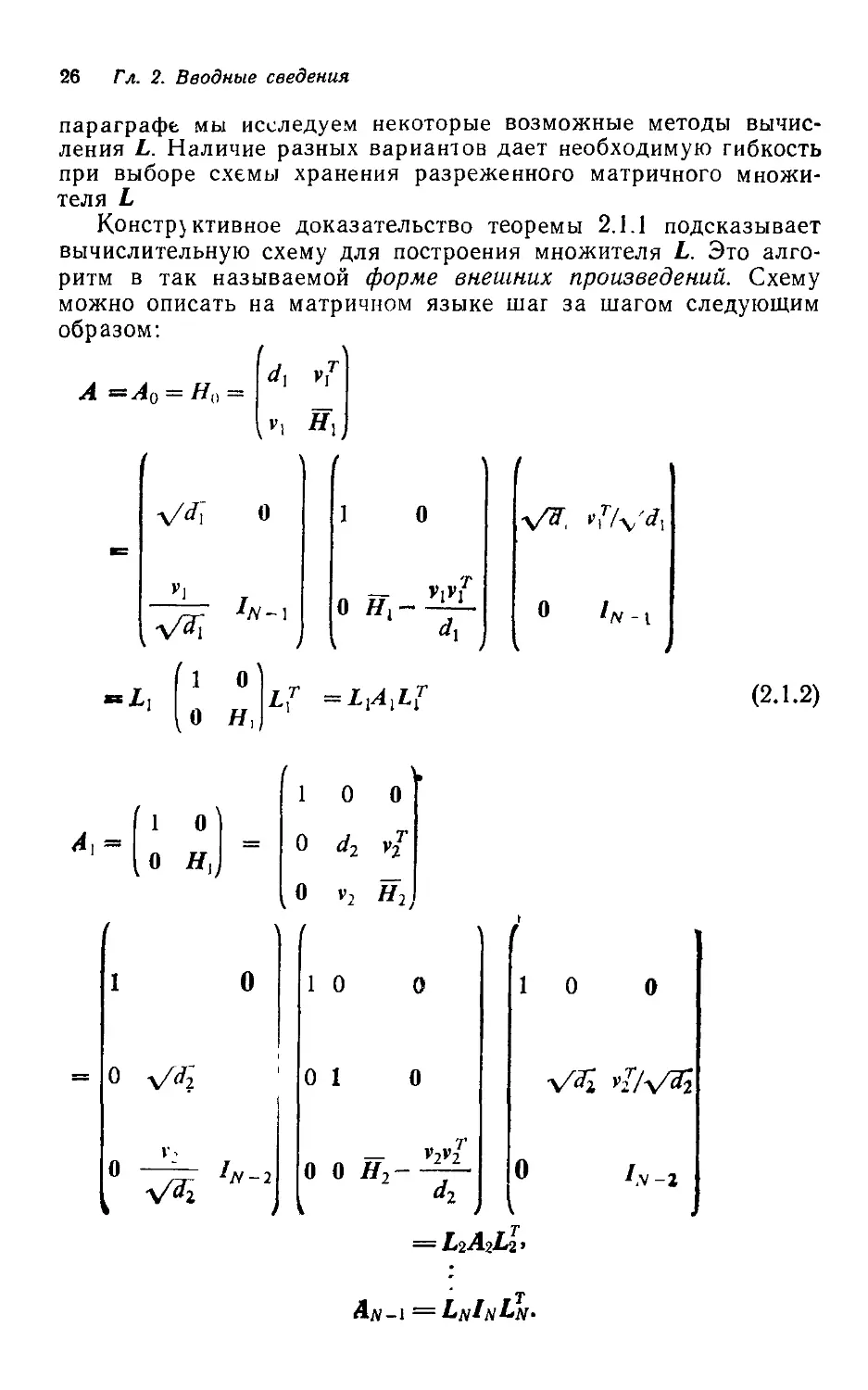

Конструктивное доказательство теоремы 2.1.1 подсказывает

вычислительную схему для построения множителя L. Это алго-

алгоритм в так называемой форме внешних произведений. Схему

можно описать на матричном языке шаг за шагом следующим

образом:

Г> #,j

1 О

1 О

о я,

L?

'/v-i

B.1.2)

О

1 О О

О d2 vj

О v2 Я2

1 О

О I

— v2v2r

О О Я2 -

1 О

О

= ?г2-Аг^2»

/v-

.v-г

An-i =LnInI>n-

§ 2.1. Алгоритм разложения 27

Здесь для значений i от 1 до N dt есть положительный ска-

скаляр, v, — вектор длины N — i, a H, — положительно определен-

определенная симметричная матрица порядка N — i.

После N шагов алгоритма имеем

А = L\Lj ... LnLn . • • LiL\ = LL .

Можно показать (см. упр. 2.1.6), что

L = Lt + L,+ ...+LN-(N-l)IN. B.1.3)

Таким образом, i-й столбец L есть в точности i-fi столбец Li.

В этой схеме вычисляются один за другим столбцы ?-_В то

же время каждый шаг требует модификации подматрицы Н, по-

посредством внешнего произведения fifj/d,. Результатом яв-

является Н,, т. е. как раз та матрица, которую остается разло-

разложить. Порядок обращения к элементам А в процессе разложе-

разложения изображен на рисунке.

Дальнейших

обращении

не требуется

Изменяемая часть

Разлагаемый столбец

Другая формулировка процесса разложения — это метод

окаймления. Пусть матрица А представлена в виде

М

причем уже получено симметричное разложение LMLTM ведущей

главной подматрицы М порядка N—1. (Почему М положи-

положительно определена?) Тогда разложением А будет

wT

/До t )

где

B.1.4)

B.1.5)

и

/ = (s — wrw)V».

(Почему число s — wTw положительно?)

28 Гл. 2. Вводные сведения

Заметим, что разложение LMLTM подматрицы М также мож-

можно получить приемом окаймления. Поэтому схема может быть

описана следующим образом:

для. i= \, 2, ..., N решить систему

'1,1

О

//-1.1.

Вычислить

аи

В этой схеме поочередно вычисляются строки L; к еще не-

разложенной части матрицы обращение не производится до тех

пор, пока не будет вычисляться соответствующая часть L. По-

Последовательность вычислений изображена на рисунке.

Вычисленная часть

матрацы; доступ

к ней открыт

К этой часта

обращение /гака

не /граазбодалось

Доступ открыт;

происходит

перестройка

Последняя схема вычисления коэффициентов L — это алго-

алгоритм в форме скалярных произведений. Его можно описать так.

Для / = 1, 2, ..., N вычислить „

I

Для i = / + 1, / + 2, ..., N вычислить

Эта формулы можно вывести непосредственно, приравнивая эле-

элементы А соответствующим элементам произведения LU.

Как и в варианте с внешними произведениями, вычисляются

один за другим столбцы L, но к той части матрицы, которая на

§ 2.1. Алгоритм разложения 29

данном шаге еще не разложена, обращения не происходит. По-

Последовательность вычислений и характер обращений к элемен-

элементам А указаны на рисунке.

Обращения

не происходит

Эта часть вы числена \

доступ к не^

открыт

Доступ открыт;

происходит

перестройка

Две последние формулировки можно изложить на языке

одних скалярных произведений. Это можно использовать для

уменьшения погрешности численного разложения, накапливая

с двойной точностью скалярные произведения. На некоторых

вычислительных машинах такое накопление требует лишь не-

небольших дополнительных затрат.

2.1.3. Разложение разреженных матриц

Как было показано в главе 1, при разложении разреженной

матрицы она обычно претерпевает некоторое заполнение, т. е.

нижний треугольный множитель L имеет ненулевые элементы

в тех позициях, где в исходной матрице стояли нули. Вспомним

разложение матрицы

4 I

2 X 2

1^-000

2 0 3 0 0

2 0 0 0 16

из § 1.1. Ее треугольный множитель L выглядит так:

2

0.5

1

0.25

I

0

0.5

-1

-0.25

0

0

1

-0.5

-2

0

0

0

0.5

-3

0

0

0

0

1

30 Гл 2 Вводные сведения

следовательно, матрица А заполнилась в позициях C,2), D,2),

D,3), E,2), E,3) и E,4). Это явление заполнения, которое

обычно игнорируют при решении плотных систем, играет крити-

критическую роль в разреженном исключении.

Причину появления ненулевых элементов можно понять

лучше, если использовать формулировку процесса факториза-

факторизации, связанную с внешними произведениями. На t-м шаге под-

подматрица Н, модифицируется посредством матрицы vivTi/dt и

получается Я,. В результате подматрица Н, может иметь нену-

ненулевые элементы в позициях, которые были нулями в Н,. В при-

приведенном выше примере

Я,=

J.

У

0

0

0

3

0

0

0

_5_

8

0

0

0

О 0 0 16

Модификация на 1-м шаге дает (с точностью до трех значащих

цифр)

О м О

.25

-.5

-.125

-.5

— S

2

-.25

-1

-.125

-.25

.563

-.25

-.5

-1

- 25

15

Если при решении разреженной системы используется нали-

наличие нулей, то от заполнения зависят и требования к памяти, и

количество вычислительной работы. Напомним, что л(П) обозна-

обозначает число ненулевых элементов в П, где П может быть векто-

вектором или матрицей. Из B.1.2) и B.1.3) видно, что число ненуле-

ненулевых элементов в L выражается форм\лой

? B.1.6)

В нижеследующей теореме, а затем на протяжении всей

книги мы измеряем количество арифметической работы числом

мультипликативных операций (умножений и делений), назы-

называемых в дальнейшем просто «операциями». Большая часть

арифметики, выполняемой в матричных расчетах, образует по-

последовательность пар «умножить — сложить», поэтому число

§ 2.1. Алгоритм разложения 31

аддитивных операций приблизительно равно числу мультипли-

мультипликативных.

Теорема 2.1.2.

Число операций, необходимых для вычисления треугольного

множителя L матрицы А, равно

? Ч W fo (* <) + 3] = у ? h (LJ - 1 ] h (JLW) + 2]. B.1.7)

Доказательство. Три формулировки разложения различаются

лишь порядком выполнения операций. Для подсчета числа опе-

операций воспользуемся алгоритмом в форме внешних произведе-

произведений B.1.2). На /-м шаге требуется r\(vt) операций для вычисле-

вычисления vj^jdi и -g- Л (ft) [T|(»f) + 1] операций для формирования

симметричной матрицы

/ V

Результат получается суммированием по всем шагам.

Для плотного случая число ненулевых элементов в L есть

±N(N+1), B.1.8)

а арифметическая работа —

JV-1

/(/ + 3)=|/V3+i/V2-|-iV. B.1.9)

Рассмотрим еще в качестве примера разреженной матрицы

разложение Холесского для симметричной положительно опре-

определенной трехдиагональной матрицы. Можно показать (см.

главу 5), что если L — множитель такой матрицы, то T](L»,) = 2

для i = 1, ..., N— 1. В этом случае число ненулевых элементов

в L есть

ti(L) = 2,V-1,

а арифметическая работа при вычислении L —

Ы-1

Сравнивая эти результаты с подсчетами для плотного слу-

случая, видим огромное различие в требованиях к памяти и вычис-

вычислительной работе.

Стоимость решения эквивалентных разреженных систем с

разными упорядочениями также может быть весьма различной

32 Га. 2. Вводные сведения

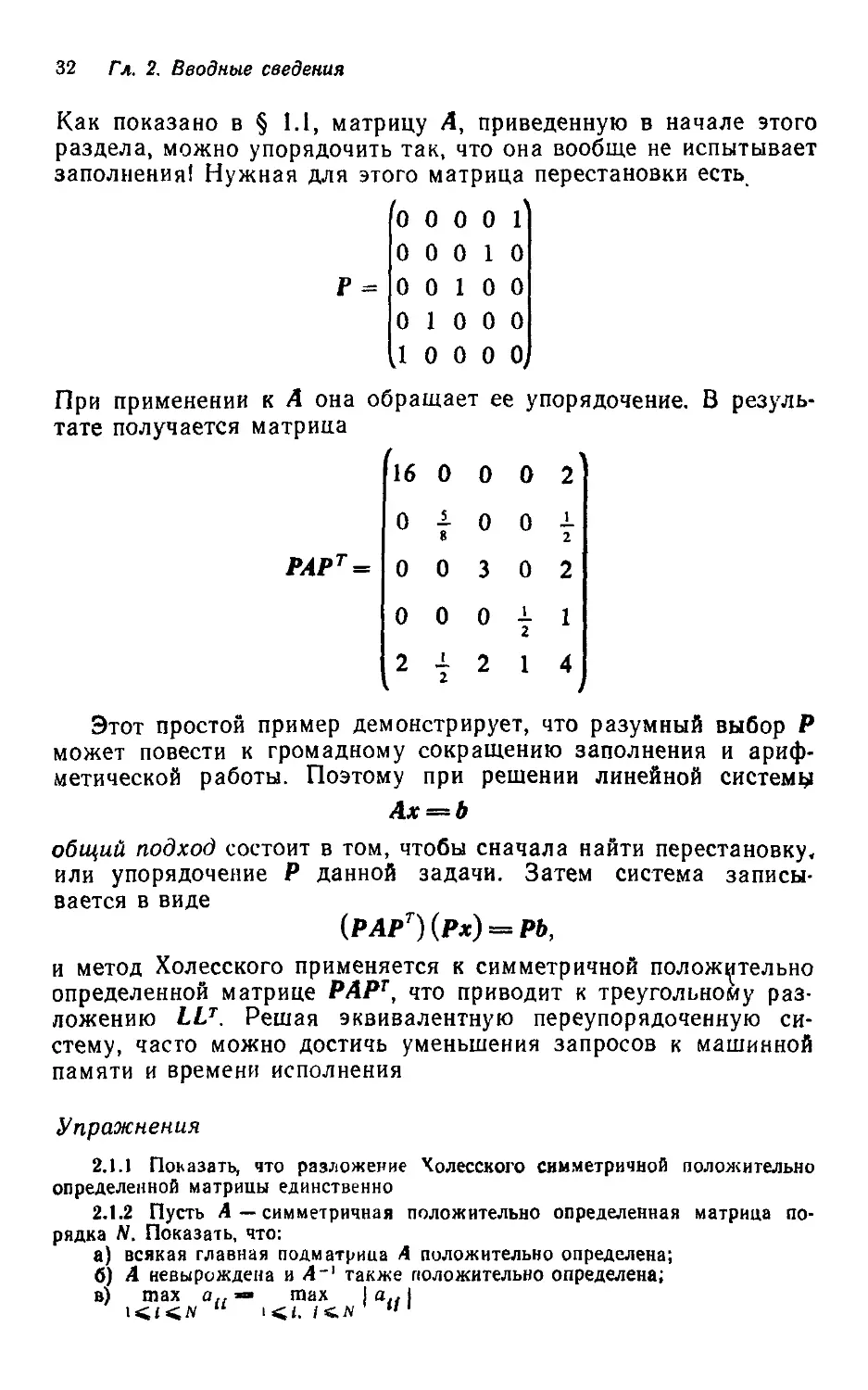

Как показано в § 1.1, матрицу А, приведенную в начале этого

раздела, можно упорядочить так, что она вообще не испытывает

заполнения! Нужная для этого матрица перестановки есть

0 0 0 0 1

0 0 0 10

0 0 10 0

0 10 0 0

.10 0 0 0,

При применении к А она обращает ее упорядочение. В резуль-

результате получается матрица

РАР1

16

0

0

0

2

0

8

0

0

0

0

3

0

2

0

0

0

1

2

1

2

7

2

1

4

Этот простой пример демонстрирует, что разумный выбор Р

может повести к громадному сокращению заполнения и ариф-

арифметической работы. Поэтому при решении линейной системы

Ах=*Ь

общий подход состоит в том, чтобы сначала найти перестановку,

или упорядочение Р данной задачи. Затем система записы-

записывается в виде

(РАРТ) (Рх) = РЬ,

и метод Холесского применяется к симметричной положительно

определенной матрице РАРТ, что приводит к треугольному раз-

разложению LLT. Решая эквивалентную переупорядоченную си-

систему, часто можно достичь уменьшения запросов к машинной

памяти и времени исполнения

Упражнения

2.1.1 Поьазать, что разложение Чолесского симметричной положительно

определенной матрицы единственно

2.1.2 Пусть А — симметричная положительно определенная матрица по-

порядка N. Показать, что:

а) всякая главная подматрица А положительно определена;

б) А невырождена и А~' также положительно определена;

в)

max

max

§22 Решение треугольных систем 33

2.1.3 Пусть А— симметричная положительно определенная матрица. По-

Показать, что

а) ВГАВ положительно определена тогда и только тогда, когда В невы-

невырождена,

б) окаймленная матрица

положительно определена тогда и только тогда, когда s > u7A~lu.

2.1.4. Записать равенства, аналогичные равенствам B 1.2), B 1.3), кото-

которые давали бы разложение LDU, где L теперь — нижняя треугольная мат-

матрица с единицами на диагонали, a D — диагональная матрица с положитель-

положительными диагональными элементами

2.1.5. Пусть Е и F — нижние треугольные матрицы порядка /V, которые

при некотором k (I ^ к ^ /V) удовлетворяют условиям: е,/ = 1 для / > к;

ец = О для i > / и / > к; fn = 1 для / =s k; ftl = 0 для « > /' и / ^ к. Слу-

Случай W = 6, k = 3 изображен на рисунке.

*

*

*

•

•

*

*

*

•

•

*

*

*

•

•

1

0

0

0

1

0 1

F =

1

0

0

0

0

0

1

0

0

0

0

1

0

0

0

*

•

*

0

*

• •

Показать, что EF = Е + F — /, и тем самым установить справедливость

B.1.3).

2.1.6 Привести пример симметричной матрицы, которая бы не имела тре-

треугольного разложения LLT, и такой, которая бы дойускала более, чем одно

разложение.

§ 2.2. Решение треугольных систем

2.2.1. Вычисление решения

После того как вычислено разложение, нужно решить тре-

треугольные системы Ly = Ъ и Ux = у. В этом параграфе будет

рассмотрено численное решение треугольных систем.

Пусть мы имеем линейную систему

Тх = Ь

порядка N, где Т — невырожденная треугольная матрица. Без

потери общности можно предположить, что Т — нижняя тре-

треугольная. Существуют два распространенных способа решения

такой системы, отличающиеся лишь порядком выполнения опе-

операций.

В первом способе используются лишь скалярные произведе-

произведения. Определяющие уравнения таковы:

34 Гл. 2. Вводные сведения

ДЛЯ i= 1, 2 N

Последовательность вычислений изображена на рисунке

1

B.2.1)

I

I

Дальнейших обращении

нетребуется

F771 Это часть вычислена;

У//А доступ к ней открыт

Ш Вычисляемая

часть

? Обращений

пока не происходи/го

Во втором способе подматрицы из Т используются таким же

образом, как в варианте внешних произведений алгоритма раз-

разложения. Определяющие уравнения выглядят так:

для i= 1, 2, .... N

х,- - bi/th

B.2.2)

bN

—

•

- x,

*

Заметим, что эта схема позволяет использовать разреженность

решения х. Если в начале /-го шага ft/ оказывается нулем, то и

Xi — нуль, и весь шаг может быть опущен. Порядок обращения

к коэффициентам системы показан на рисунке.

вяа Дальнейших обращений

БеЭ не требуется

ртя Эта часть Вычислена;

ч61 доступ к ней открыт

U

Вычисляемая

часть

Обращении

пока не происходи/1 о

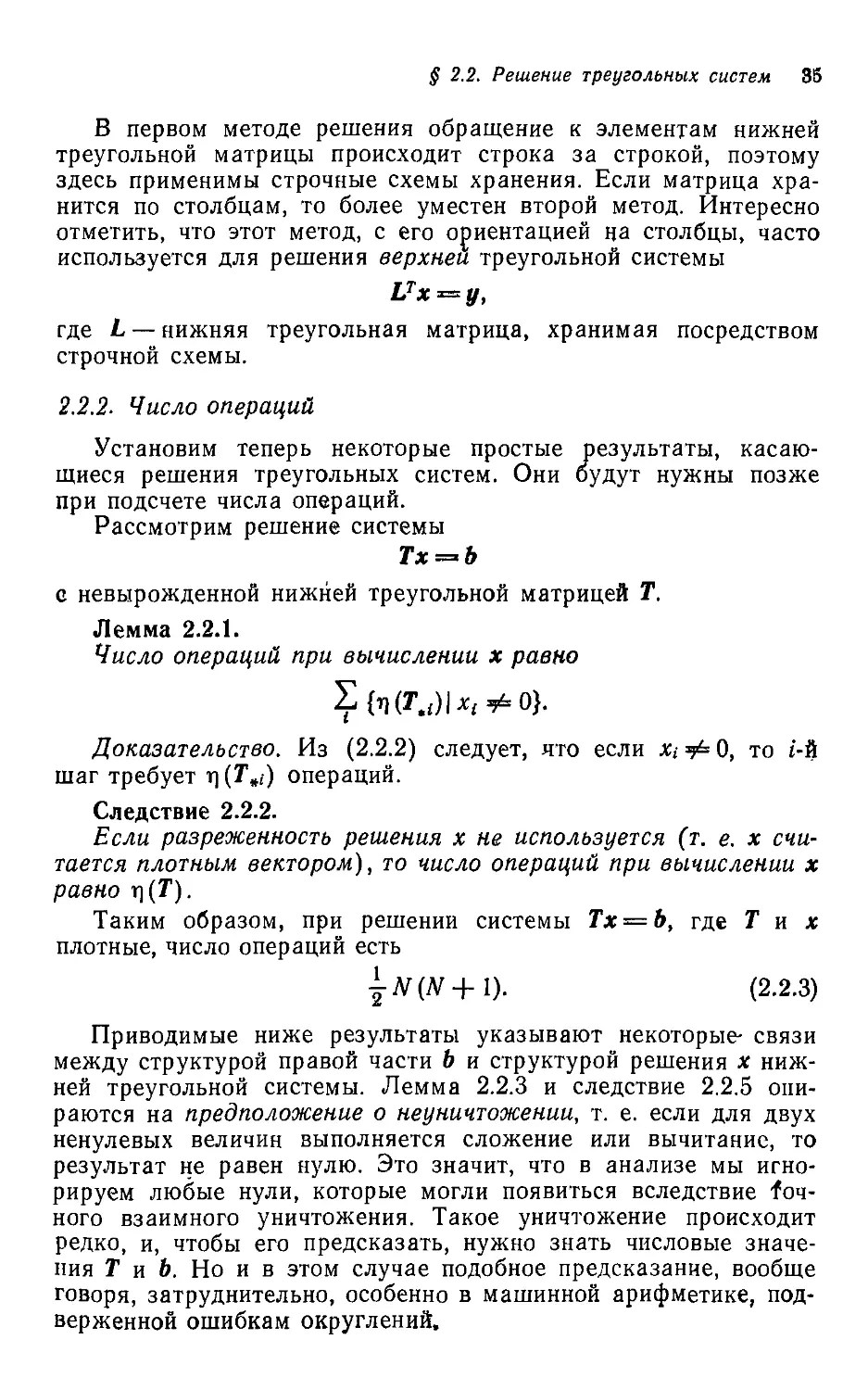

§ 2.2. Решение треугольных систем 35

В первом методе решения обращение к элементам нижней

треугольной матрицы происходит строка за строкой, поэтому

здесь применимы строчные схемы хранения. Если матрица хра-

хранится по столбцам, то более уместен второй метод. Интересно

отметить, что этот метод, с его ориентацией на столбцы, часто

используется для решения верхней треугольной системы

где L — нижняя треугольная матрица, хранимая посредством

строчной схемы.

2.2.2. Число операций

Установим теперь некоторые простые результаты, касаю-

касающиеся решения треугольных систем. Они будут нужны позже

при подсчете числа операций.

Рассмотрим решение системы

Г* = &

с невырожденной нижней треугольной матрицей Т.

Лемма 2.2.1.

Число операций при вычислении х равно

i

Доказательство. Из B.2.2) следует, что если Xi Ф 0, то г-й

шаг требует х\ (Т*,) операций.

Следствие 2.2.2.

Если разреженность решения х не используется (т. е. х счи-

считается плотным вектором), то число операций при вычислении х

равно г\(Т).

Таким образом, при решении системы Тх = Ь, где Тих

плотные, число операций есть

jN(N + l). B.2.3)

Приводимые ниже результаты указывают некоторые- связи

между структурой правой части Ь и структурой решения х ниж-

нижней треугольной системы. Лемма 2.2.3 и следствие 2.2.5 опи-

опираются на предположение о неуничтожении, т. е. если для двух

ненулевых величин выполняется сложение или вычитание, то

результат не равен нулю. Это значит, что в анализе мы игно-

игнорируем любые нули, которые могли появиться вследствие точ-

точного взаимного уничтожения. Такое уничтожение происходит

редко, и, чтобы его предсказать, нужно знать числовые значе-

значения Тиб. Но и в этом случае подобное предсказание, вообще

говоря, затруднительно, особенно в машинной арифметике, под-

подверженной ошибкам округлений.

36 Гл 2. Вводные сведения

Лемма 2.2.3.

В предположении о неуничтожении из bi ф О следует х, Ф О.

Доказательство. Поскольку Т невырожденна, tu Ф 0 для

1 ^ i ^ N. Теперь нужный результат следует из предположения

о неуничтожении и определяющего уравнения B.2.1) для Xi.

Лемма 2.2.4.

Пусть х — решение системы Тх = Ь. Если bt = О для l^ii^ik,

то я, = О для 1 ^ i '^С k.

Следствие 2.2.5.

При предположении о неуничтожении справедливо неравен-

неравенство х\{Ь) ^ ц{х).

Упражнения

2.2.1. Используя лемму 2.2.1, показать, что разложение по схеме окайм-

окаймления требует

4" Ц A №*(> - ») (Л №**) + 2)

операций.

2.2.2. Показать, что обратная к невырожденной нижней треугольной мат-

матрице также нижняя треугольная (использовать лемму 2.2.4).

2.2.3. Пусть Т — невырожденная нижняя треугольная матрица со свой-

свойством распространения, т. е. t,, ;_i ф 0 для 2 ^ i ^ N.

а) Показать, что при решении системы Тх = b из bi ф 0 следует х/ Ф О

для ( ^ / ^ N.

б) Показать, что Т~1 — заполненная нижняя треугольная матрица.

2.2.4. Зависит ли лемма 2.2.1 от предположения о неуничтожении? Объ-

Объяснить. Ответить на тот же вопрос в отношении теоремы 2.1.2 и леммы 2.2.4.

2.2.5. Доказать результат, аналогичный лемме 2 2.4, для верхних тре-

треугольных матриц.

2.2.6. Предположим, что нужно решить большое число нижних треуголь-

треугольных систем вида Ly = Ь порядка N, причем и L, и векторы b разрежены.

Известно, что для этих систем разрежены и решения у. Имеется выбор из

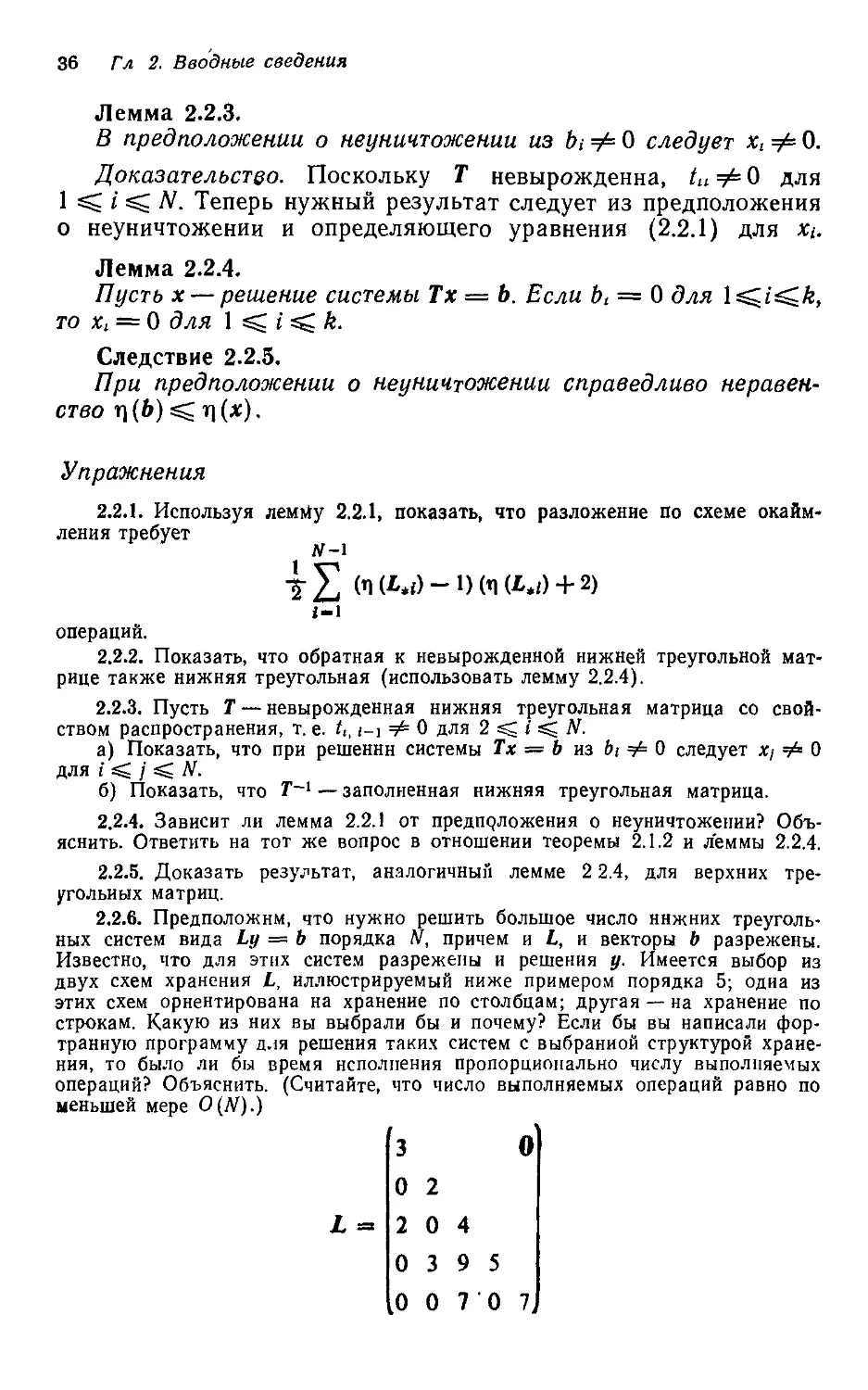

двух схем хранения L, иллюстрируемый ниже примером порядка 5; одна из

этих схем ориентирована на хранение по столбцам; другая — на хранение по

строкам. Какую из них вы выбрали бы и почему? Если бы вы написали фор-

транную программу для решения таких систем с выбранной структурой хране-

хранения, то было ли бы время исполнения пропорционально числу выполняемых

операций? Объяснить. (Считайте, что число выполняемых операций равно по

меньшей мере O(N).)

3 О

О 2

2 0 4

0 3 9 5

0 0 7 0 7

§ 2.2. Решение треугольных систем 37

1

1

2 4

2 3

3 9

ТТТ~1 , .

1 2 3 5 8 10

Схема 1

3 5

1

з~Т

2 4

3 4 5

4 $ 7

10

Индексы столбцов

Числовые значения

Индексный вектор

" Индексы строк

' Числовые значений

Индексный вектор

2.2.7. Пусть L и W —NXN нижние треугольные матрицы с ненулевыми

диагональными элементами, не являющиеся разреженными. Указать прибли-

приблизительное число операций для вычисления L~XW To же самое в отношении

вычисления WW

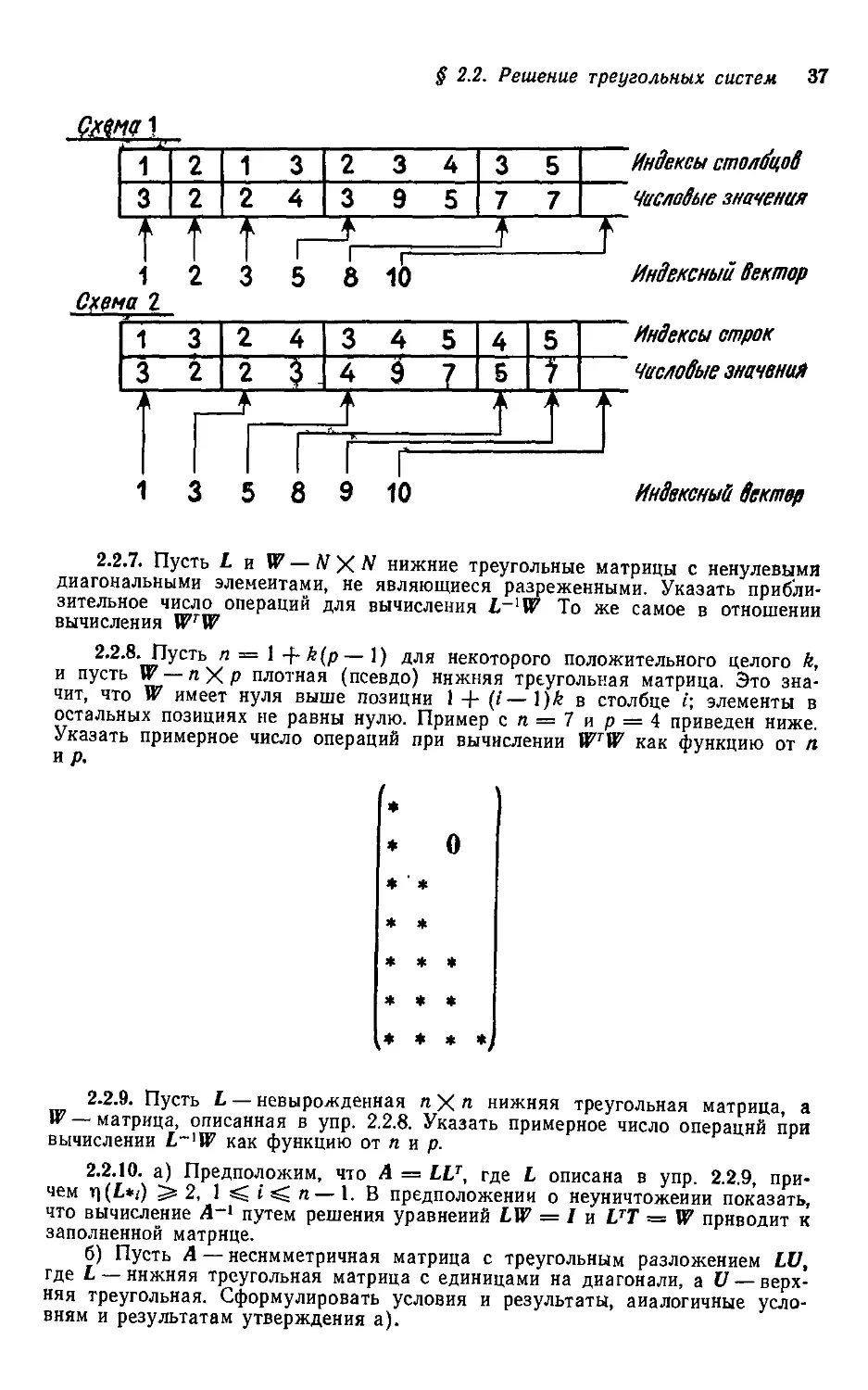

2.2.8. Пусть п = 1 -hk(p—1) для некоторого положительного целого k,

и пусть W — п X р плотная (псевдо) нижняя треугольная матрица. Это зна-

значит, что W имеет нуля выше позиции 1 + (/—\)k в столбце i; элементы в

остальных позициях не равны нулю. Пример сп = 7ир = 4 приведен ниже.

Указать примерное число операций при вычислении WTW как функцию от я

и р.

* о

* ' *

* *

* * *

* * *

* * * *

2.2.9. Пусть L — невырожденная яХл нижняя треугольная матрица, а

W—матрица, описанная в упр. 2.2.8. Указать примерное число операций при

вычислении L-'W как функцию от п и р.

2.2.10. а) Предположим, что А = LU, где L описана в упр. 2.2.9, при-

причем i\(L*t) 5s 2, 1 ^ i ^ п—1. В предположении о неуничтожеиии показать,

что вычисление А~1 путем решения уравнений LW = / и UT = W приводит к

заполненной матрице.

б) Пусть А — несимметричная матрица с треугольным разложением LV,

где L — нижняя треугольная матрица с единицами на диагонали, а V — верх-

верхняя треугольная. Сформулировать условия и результаты, аналогичные усло-

условиям и результатам утверждения а).

88 Гл 2. Вводные сведения

§ 2.3. Некоторые практические замечания

Целью изучения разреженной матричной технологии решения

линейных систем является снижение стоимости использования

разреженности данной системы. Сравнивая в разделе 2.1.3 ре-

решение плотной и трехдиагональной системы, мы видели, что

можно достигнуть огромных сокращений в запросах к памяти

и вычислительной работе.

Имеются различные схемы хранения разреженных матриц,

отличающиеся способом использования нулей. В некоторых слу-

случаях допускается хранение части нулей в обмен на упрощение

схемы хранения; в других — используются все нули системы,

В главах 4—8 мы обсудим наиболее распространенные разре-

разреженные схемы решения линейных систем.

Выбор метода хранения, естественно, влияет на запросы

к памяти и на использование стратегии упорядочения (выбор

матрицы перестановки Р). Кроме того, он оказывает сущест-

существенное воздействие на реализацию разложения и решения, а

следовательно, на сложность программ и время исполнения.

Однако, независимо от того какая схема разреженного хра-

хранения используется, в вычислительном процессе в целом могут

быть выделены четыре фазы.

Шаг 1 (упорядочение). Найти «хорошее» упорядочение (пе-

(перестановку Р) для данной матрицы А с учетом выбранного

метода хранения.

Шаг 2 (распределение памяти). Определить необходимую

информацию о множителе Холесского L матрицы РАРТ с тем,

чтобы сформировать подходящую схему хранения.

Шаг 3 (разложение). Разложить переупорядоченную матри-

матрицу РАРТ в произведение LU.

Шаг 4 (решение треугольных систем). Решить системы Ly =

¦в Ь и Uz = у. После этого положить х = Ртг.

Даже при заданном методе хранения имеется много способов

для выбора упорядочения, определения подходящей структуры

хранения и выполнения реальных вычислений. Схему разрежен-

разреженного хранения вместе с соответствующей комбинацией упоря-

упорядочения/распределения памяти/разложения/решения мы будем

в дальнейшем называть методом решения.

Чаще всего называемыми задачами при выборе метода ре-

решения являются: а) уменьшить запросы к памяти; б) уменьшить

время исполнения; в) уменьшить некоторую комбинацию памяти

и времени исполнения; эта комбинация отражает относительную

цену ресурсов в стоимости использования машинной системы.

Хотя есть и другие критерии, иногда управляющие выбором ме-

метода, названные являются главными. Они иллюстрируют труд-

трудности, связанные с оценкой стратегии.

§ 2.3. Некоторые практические замечания 39

Чтобы можно было заявить, что один метод лучше другого

в смысле одной из указанных выше мер, нужно иметь возмож-

возможность точно оценить эту меру для каждого метода, а такая

оценка значительно сложнее, чем кажется. Рассмотрим вначале

критерий машинной памяти.

2.3.1. Запросы к памяти

Память, используемая для хранения разреженных матриц,

обычно состоит из двух частей: основной памяти, содержащей

числовые значения, и накладной памяти, где хранятся указа-

указатели, индексы и другая информация, нужная для запоминания

Основная

память

Номадная

память

Основная

память

Накладная

память

Рис. 2.3.1. Основная и накладная память для двух различных методов.

структуры матрицы и облегчения доступа к числовым значе-

значениям. Поскольку за машинную память приходится платить не-

независимо от того, как она используется, всякая оценка запросов

к памяти для данного метода решения должна включать описа-

описание способа, которым будут храниться матрица или матрицы,

так чтобы в этой оценке накладная память могла быть учтена

наряду с основной.

Сравнение двух различных стратегий с точки зрения крите-

критерия памяти может сводиться к сравнению существенно различ-

различных структур данных, имеющих весьма различающуюся на-

накладную память. Поэтому метод, предпочтительный в смысле

величины основной памяти, может уступать конкуренту, если

в сравнении учитывается и накладная память. Эту ситуацию

иллюстрирует рис. 2.3.1.

В качестве простого примера рассмотрим два упорядочения

матрицы на рис. 2.3.2 и соответствующие множители L и L. Эле-

Элементы нижнего треугольника L (исключая диагональ) хранятся

построчно в едином массиве; параллельный массив содержит

их столбцовые индексы. Третий массив указывает положение

каждой строки, а четвертый хранит диагональные элементы L

40 Гл 2 Вводные сведения

Для хранения матрицы L использована так называемая про-

профильная схема, описываемая в главе 4. Ненулевые элементы А

обозначаются символом *, а элементы заполнения в L или L —

звездочкой в кружочке.

* *

* *

* * * *

* * * *

* * *

* *

*#

* *

*г Пг Т^

*

Ч» -Г* Уг

*

Рис. 2.3.2. Два различных упорядочения разреженной матрицы А и erpjKTypa

ненулевых элементов соответствующих треугольных множителей L и L

Примеры на рисунках 2,3.2 и 2.3.3 иллюстрируют некоторые

важные моменты, связанные с упорядочениями и схемами хра-

хранения На поверхностный взгляд упорядочение 1, соответствую-

соответствующее А, кажется лучше, чем упорядочение 2, поскольку оно

вообще не приводит к заполнению, в то время как при втором

упорядочении заполнение состоит из двух элементов. Кроме

того, и схема хранения, выбранная для L, кажется хуже той,

что использована для L, поскольку первая игнорирует наличие

некоторых нулей, а в L разреженность эксплуатируется на сто

процентов. Однако из-за различий в накладной памяти комби-

комбинация упорядочения и хранения во втором случае приводит к

меньшим общим запросам к памяти. Конечно, различия здесь

тривиальны, но сам вывод полностью сохраняет силу. По мере

§ 2.3. Некоторые практические замечания 41

того как усложняется схема хранения, во все большей мере

используя нули, основная память уменьшается, а накладная

обычно возрастает. Наступает момент, когда имеет смысл игно-

игнорировать некоторые нули, поскольку накладная память, необхо-

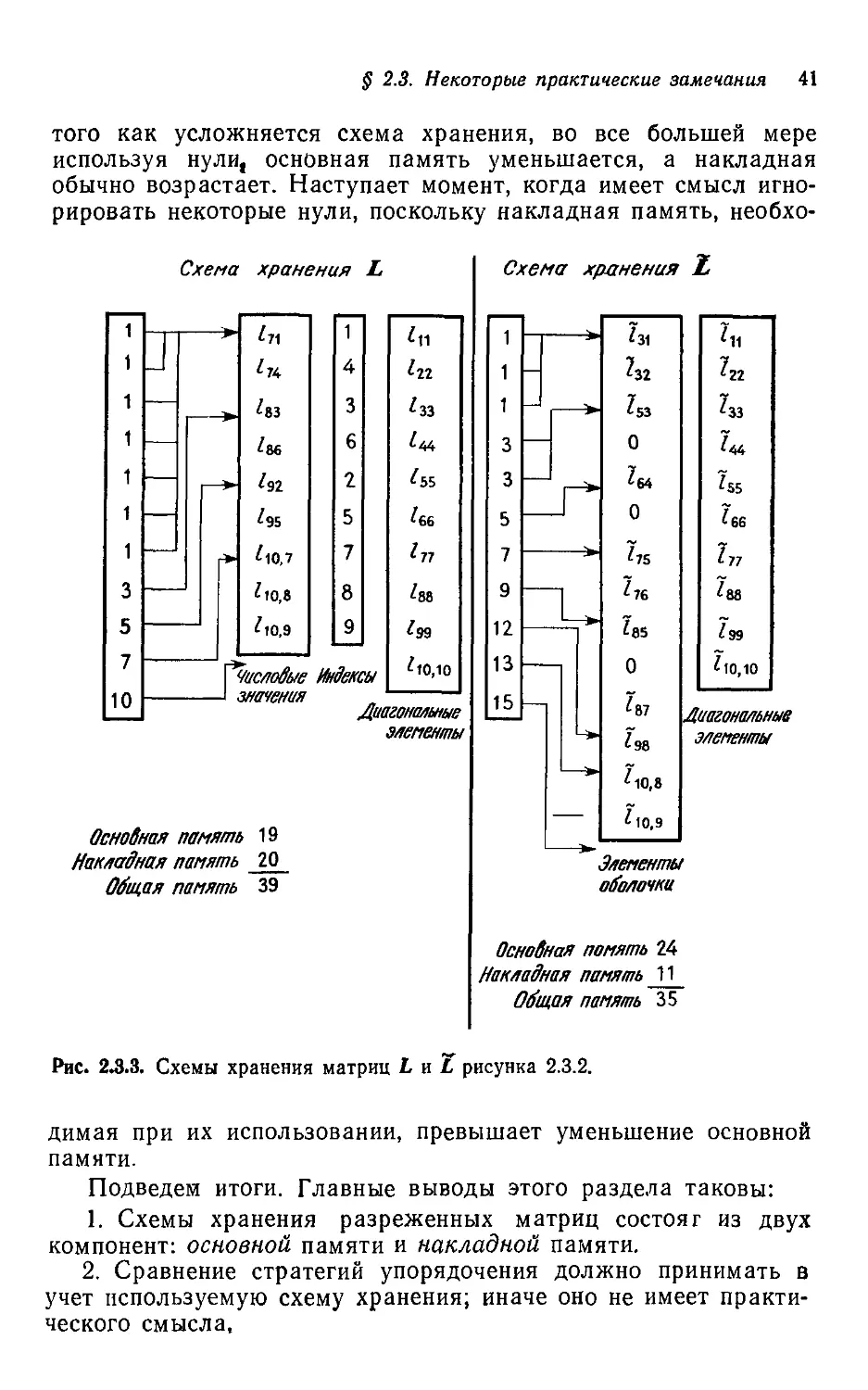

Схема хранения L

'8з

'ее

Is2

'95

'iO,7

'ю,8

'iO,9

Числовые Индексы

значения

'и

1гг

'зз

'55

'бб

'77

'88

'10,10

элементы

ОсноЙная память 19

Накладная память 20

Общая память 39

Схема хранения ?

1

1

1

3

3

5

7

9

12

13

15

г—~^

—

г*

i

I

L

—I

->

¦-

'31

?32

у

0

?64

0

'75

'76

?85

0

'87

'~98

^10,8

h

7а

У

с

'S5

'бб

In

'88

'99

'10,10

Липронпльныв

гЩл tic* t/f/tlffl/ffGru

элементы

Элементы

оболочки

Основная помять 24

//окладная память 11

память 35

Рис. 2.3.3. Схемы хранения матриц L пТ рисунка 2.3.2.

димая при их использовании, превышает уменьшение основной

памяти.

Подведем итоги. Главные выводы этого раздела таковы:

1. Схемы хранения разреженных матриц состоят из двух

компонент: основной памяти и накладной памяти.

2. Сравнение стратегий упорядочения должно принимать в

учет используемую схему хранения; иначе оно не имеет практи-

практического смысла.

42 Гл. 2. Вводные сведения

2.3.2. Время исполнения

Перейдем теперь к критерию времени исполнения. При об-

обсуждении полезно выделить четыре этапа всего вычислитель-

вычислительного процесса: упорядочение, распределение памяти, разложе-

разложение и решение.

Как мы увидим в главе 9, время исполнения, необходимое

для различных упорядочений, может меняться в очень широких

пределах. Но даже если упорядочение найдено, остается сделать

еще многое, прежде чем можно будет начать реальные вычис-

вычисления. Нужно сформировать подходящую схему хранения для L,

а чтобы сделать это, нужно определить структуру L. Этот этап

распределения памяти также различен по стоимости в зависи-

зависимости от того, какие упорядочение и схема хранения применены.

Наконец, как демонстрируют многочисленные эксперименты,

представленные в главе 9, различия в схеме хранения могут

повести к существенным различиям в числе арифметических

операций, выполняемых в секунду, на этапах разложения и ре-

решения треугольных систем.

Обычно время исполнения разреженной матричной програм-

программы примерно пропорционально' (или должно быть пропорцио-

пропорционально) количеству производимой арифметики. Однако различия

в упорядочении и структуре данных могут привести к боль-

большим различиям в константе пропорциональности. Таким обра-

образом, число арифметических операций может быть не очень на-

надежной основой сравнения различных методов решения; по

крайней мере им следует пользоваться осмотрительно. Не кон-

константу пропорциональности влияет не только примененная струк-

структура данных, но также архитектура машины, транслятор и опе-

операционная система.

В дополнение к вариации относительных стоимостей испол-

HejHfl каждого из рассмотренных выше этапов сравнение раз-

различных стратегий часто зависит от конкретных обстоятельств

решаемой задачи. Если данную матричную задачу нужно ре-

решать лишь однажды, то сравнение стратегий, конечно, должно

включать время, необходимое для определения упорядочения и

формирования схемы хранения.

Напротив, если предстоит решать много различных задач

с одинаковой структурой, то при сравнении методов может ока-

оказаться оправданным игнорирование стоимости этого начального

этапа, поскольку львиную долю машинного времени забирают

разложение и решение треугольных систем. При других обстоя-

обстоятельствах нужно решать ряд систем, различающихся лишь пра-

правыми частями. В такой ситуации, может быть, разумно сравни-

сравнивать различные стратегии на основании времени, которого они

требуют при решении треугольных систем.

§23 Некоторые практические замечания 48

Подведем итоги. Главные выводы этого раздела таковы:

1. Весь процесс решения системы Ах = Ь состоит из четырех

основных этапов. Доля общего машинного времени, приходя-

приходящаяся на каждый из них, в общем случае существенно меняется

в зависимости от упорядочения и схемы хранения.

2. В соответствии с обстоятельствами конкретной задачи

время исполнения некоторых из упомянутых этапов может быть

практически несущественным при сравнении различных методов.

Упражнения

2.3.1. Предположим, что вы имеете выбор из двух методов решения раз-

разреженной системы уравнений Ах = Ь — метода 1 и метода 2, критерием вы-

выбора метода является время исполнения ^тапы упорядочения и распределе-

распределения памяти для метода 1 требуют совместно 20 секунд; соответствующее

время для метода 2 — всего лишь 2 секунды. Время разложения в методе

1 равно 6 секундам, а решения треугольной системы—0,5 секунды; для метода

2 соответствующие показатели равны 10 секундам и 1,5 секунды

а) Какой метод вы выбрали бы, если систему нужно решить лишь од-

однажды'

б) Какой метод вы выбрали бы, если нужно решить двенадцать систем

Ах = Ь с одинаковой структурой разреженности, но разными числовыми зна-

значениями А и 6?

в) Как бы вы ответили на вопрос б), если бы у систем различались лишь

числовые значения правых частей 6?

2.3.2. Предположим, что для данного класса разреженных положительно

определенных матричных задач имеется выбор из двух упорядочений, условно

называемых «черепаха» и «заяц» Ваш друг Пнтер показал, что упорядочение

«черепахой» дает треугольные множители, каждый из которых имеет ненуле-

ненулевых элементов щ(Ы)&Ы^2+ N—^fR; здесь N — порядок задачи. Он показал

также, что соответствующая функция для упорядочения «зайцем»_есть

¦ПЛ (TV) « 7.757Vlog2 (V# + l)-24W+ 11.5 -\/N\og2 (У# + l) + Пл/N +

+0.75 log2(V^ + 0-Еще один ваш приятель Гарольд написал программы ре-

решения линейных систем, использующие схемы хранения, подогнанные к соот-

соответствующему упорядочению. Гарольд обнаружил, что при реализации упоря-

упорядочения «зайцем» ему требуются по одному целому числу (индексу) для каж-

каждого ненулевого элемента L и, кроме того, еще три массива указателей; каж-

каждый массив — длины N. При реализации упорядочения «черепахой> накладная

память состоит лишь из N указателей.

а) Предположим, что ваш выбор метода основан исключительно на об-

общем объеме памяти, необходимом для хранения L, и что целые числа, как и

числа с плавающей точкой, хранятся полным машинным словом. Для каких

значений N вы использовали бы упорядочение «зайцем»1

б) Что бы вы ответили на вопрос а), если бы Гарольд переделал свои

программы так, чтобы целые числа были упакованы в машинном слове по

три?

3. Некоторые сведения из теории графов

и ее применение к исследованию

разреженных симметричных матриц

§ 3.0. Введение

В этой главе будут введены некоторые основные понятия

теории графов и установлено их соответствие с матричными

понятиями. Хотя лишь немногие результаты теории графов

нашли прямое приложение в анализе разреженных матричных

вычислений, ее обозначения и понятия удобны и полезны в опи-

описании алгоритмов, а также в опознании и характеризации струк-

структуры матрицы. Однако при использовании теории графов в та-

такого рода анализе легко перейти разумную грань; результат

ч"асто будет тот, что терминологическая элегантность затемняет

смысл некоторых по существу простых идей. Поэтому, принося,

возможно, в жертву единообразие изложения, мы всюду, где

это уместно и на пользу делу, даем определения и результаты

в терминах как теории графов, так и теории матриц. По тем же

причинам мы предпочитаем вводить большую часть терминов

теории графов там, где в этом возникает потребность, вместо

того чтобы ввести их все в этой главе, а затем отсылать к ней

в последующем тексте.

§ 3.1. Основная терминология и некоторые определения

Для наших целей граф G = (X, Е) можно представлять себе

состоящим из конечного множества узлов, или вершин, вместе

с множеством Е ребер, которые суть неупорядоченные пары вер-

шнн. Упорядочение {помечивание) а графа G = (X, Е) есть

попросту отображение множества {1, 2, ..., N} на X; здесь

N — число узлов G. Если специально не оговорено противопо-

противоположное, граф считается неупорядоченным. Граф G, помеченный

посредством а, будет обозначаться через Ga — (Ха, Е).

Вводя графы, мы намереваемся облегчить изучение разре-

разреженных матриц; поэтому сейчас мы установим связи между гра-

графами и матрицами. Пусть А— симметричная матрица порядка

N. Упорядоченный (помеченный) граф матрицы А, обозначае-

обозначаемый GA =(ХА, ЕА), — это граф, для которого N вершин GA про-

пронумерованы числами от 1 до /V и {*,-, х,} е ЕА тогда и только

§ 3.1. Терминология и некоторые определения 45

*

CD*

* © * *

* © *

* ©

* © *

* * ©

Матрица Л

Рис. 3.1.1. Матрица и ее помеченный граф. Символ * обозначает ненулевой

элемент А.

© *

* © * *

* (D *

* 0 *

*© *

* *

© * *

© *

* *©

*

Рис. 3.1.2. Граф рисунка 3 1.1 гтри различных помечивапиях и структуры со-

соответствующих матриц. Здесь Р и Q обозначают матрицы перестановок.

46 Гл. 8, Некоторые сведения из теории графов

тогда, когда a,j = а,, ФО, 1ф ']. Здесь х, — узел ХА с меткой /.

Рис. 3.1 Л иллюстрирует структуру матрицы и ее помеченного

графа. Чтобы подчеркнуть соответствие г'-го диагонального эле-

элемента матрицы с узлом i ее графа, мы указываем этот элемент

как i в кружочке. Внедиагональные ненулевые элементы обозна-

обозначены символом *.

Если Рф1 — произвольная (Л^Х Щ -матрица перестановки,

то непомеченные графы матриц А и РАРТ совпадают, а соот-

соответствующие помечивания различны. Таким образом, непоме-

непомеченный граф А представляет структуру А без упоминания о

каком-либо конкретном упорядочении. Он изображает класс

эквивалентности матриц РАРТ, где Р — любая (NX W)-матрица

перестановки. Отыскание «хорошей» перестановки для А можно

рассматривать как отыскание хорошего помечивания для ее

графа. Рис. 3.1.2 иллюстрирует сказанное.

Некоторые определения теории графов связаны с непомечен-

непомеченными графами. Чтобы интерпретировать такие определения в

матричных терминах, нужно ввести соответствующую матрицу,

что немедленно приводит к упорядочению графа. Хотя это и не

должно вызвать недор'азумсний, читателю все же не следует

приписывать какого-либо значения конкретному упорядочению,

выбираемому в наших матричных примерах и интерпретациях.

Когда мы говорим о «матрице, соответствующей графу G», мы

либо оговариваем некоторое упорядочение а для G, либо под-

подразумеваем, что упорядочение может быть произвольным.

Два узла х и у из G называются смежными, если {х, у} & Е.

Если У cr X'), то смежное множество для У есть

Adj (У) = {х <= X — У | {х, y}<sE для некоторого у <= У). C.1.1)

Словами: Adj (У) есть множество узлов G, не принадлежащих

У, но смежных хотя бы с одним узлом из У. Рис. 3.1.3 иллюстри-

иллюстрирует матричную интерпретацию множества Adj (У). Для удоб-

удобства узлы множества У были помечены последовательными це-

целыми числами. Если У имеет единственную вершину у, будем

писать Adj (у) вместо формально правильного Adj ({«/}).

Для УаХ степень У, обозначаемая через Deg(K), есть число

|Adj(K)|, где |5| — обозначение числа элементов множества 5.

Опять-таки, если У имеет единственную вершину у, будем писать

Deg(«/), а не Deg({«/}). Например, на рис. 3.1.3 Deg(Ar2)=3.

Частью G' = (X', Е ) графа G называется граф, для которого

Х'аХ и Е'сЕ. Если УаХ, то подграф G(y) — это часть

(У, Е(У)) графа G, такая, что

Я (К)-={{*, y}<sE\x<=Y, уввУ}. C.1.2)

') Здесь и всюду в книге обозначение У с: X допускает, что Y может

совпадать с X. Если важно, чтобы У было собственным подмножеством X,

это будет явно оговариваться.

§ S.I. Терминология и некоторые определения 47

На матричном языке подграф G(Y)— это граф матрицы, полу-

полученной из матрицы графа G вычеркиванием всех строк и столб-

столбцов, кроме тех, которые соответствуют У. Это иллюстрируется

рисунком 3.1.4.

Y =

Adj(Y) =.

Рис. 3.1.3. Иллюстрация к понятию смежного множества для множества

УаХ.

Подграф называется кликой, если все его узлы попарно

смежны. В матричной терминологии клике соответствует запол-

заполненная подматрица. Например, G({x2, xj) является кликой.

© *

* C)

Матрица

подграфа G(y)

GQO

Рис. 3.1.4. Пример подграфа G(Y) и соответствующей подматрицы. Исходный

граф G изображен на рис. 3.1.1.

Пример на рис. 3.1.4 иллюстрирует понятие, которое мы сей-

сейчас исследуем, а именно связность графа. Если х и у — различ-

различные узлы G, то путем из х в у длины / ^ 1 называется упорядо-

упорядоченное множество из /+1 различных узлов (vu v2, ..., иг+i)»

48 Гл. 3. Некоторые сведения из теории графов

такое, что vl+1 e Adj(i><), i«l,2 /, причем v, — х, vt+i =

= f/. Граф называется связным, если каждая пара различных

узлов соединена хотя бы одним путем. В противном случае G

несвязен и состоит из двух или более связных компонент. Если

говорить о матричных аналогиях, то должно быть ясно, что для

П

уть:

Рис 3.1. 5.Путь в графе и соответствующая матричная интерпретация.

несвязного графа О, состоящего из k связных компонент, при

последовательном помечивании этих компонент соответствую-

соответствующая матрица будет блочно-диагональной и каждый диагональ-

диагональный блок ассоциирован со связной компонентой. Граф G{Y) на

рис. 3.1.4 упорядочен именно так, и соответствующая ему ма-

матрица— блочно-диагональная. Рис. 3.1.5 показывает некоторый

путь в графе и его матричную интерпретацию.

Наконец, множество Y cz X называется разделителем связ-

связного графа G, если подграф G(X—У) несвязен. Так, например,

К== {л:3, xit Хь)—разделитель графа на рис. 3.1.5, потому что

граф G(X — Y) состоит из трех компонент с узловыми множест-

множествами {xi}, {xi} и {хб, хт) соответственно.

§ 3.2. Машинное представление графов 49

Упражнения

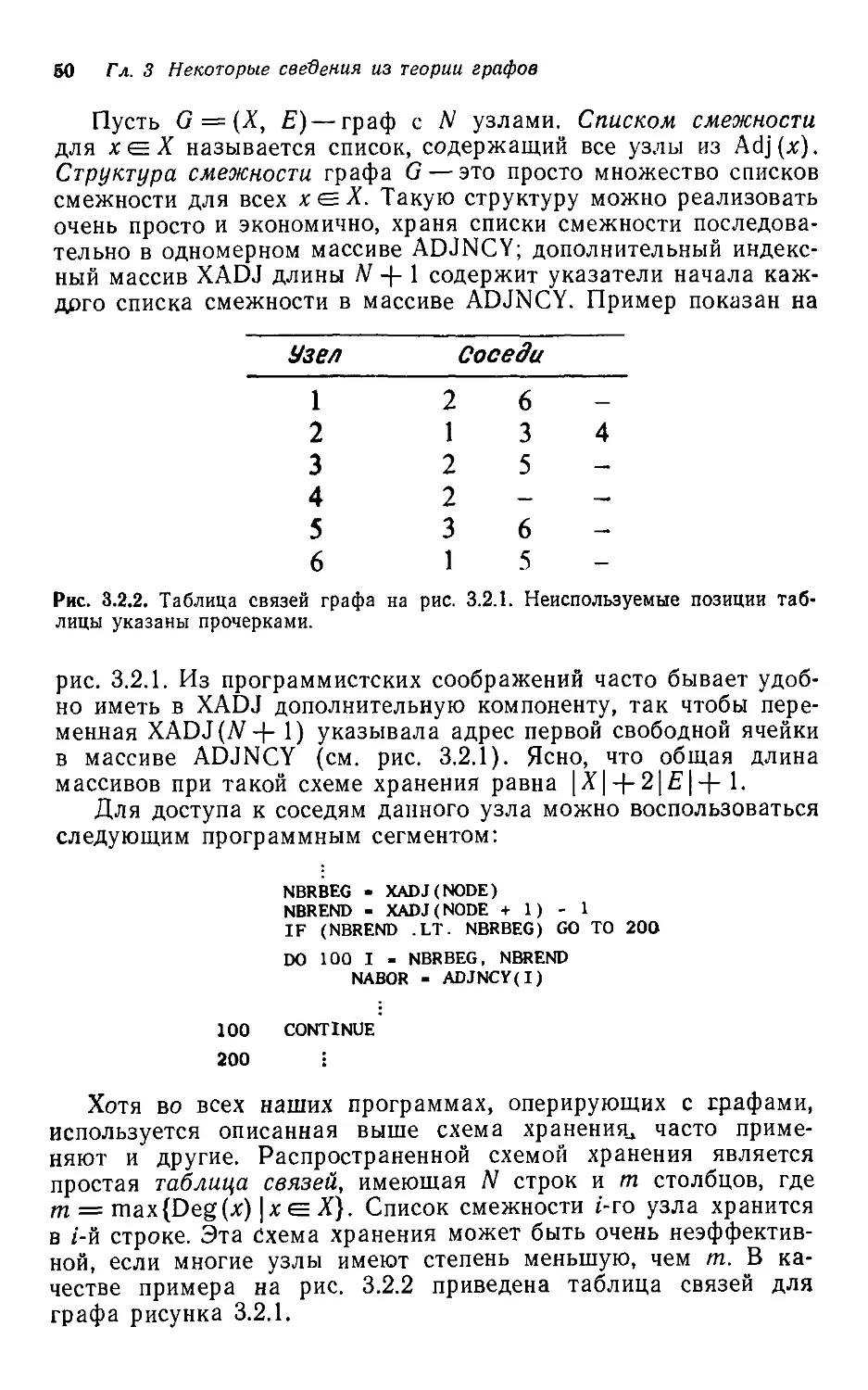

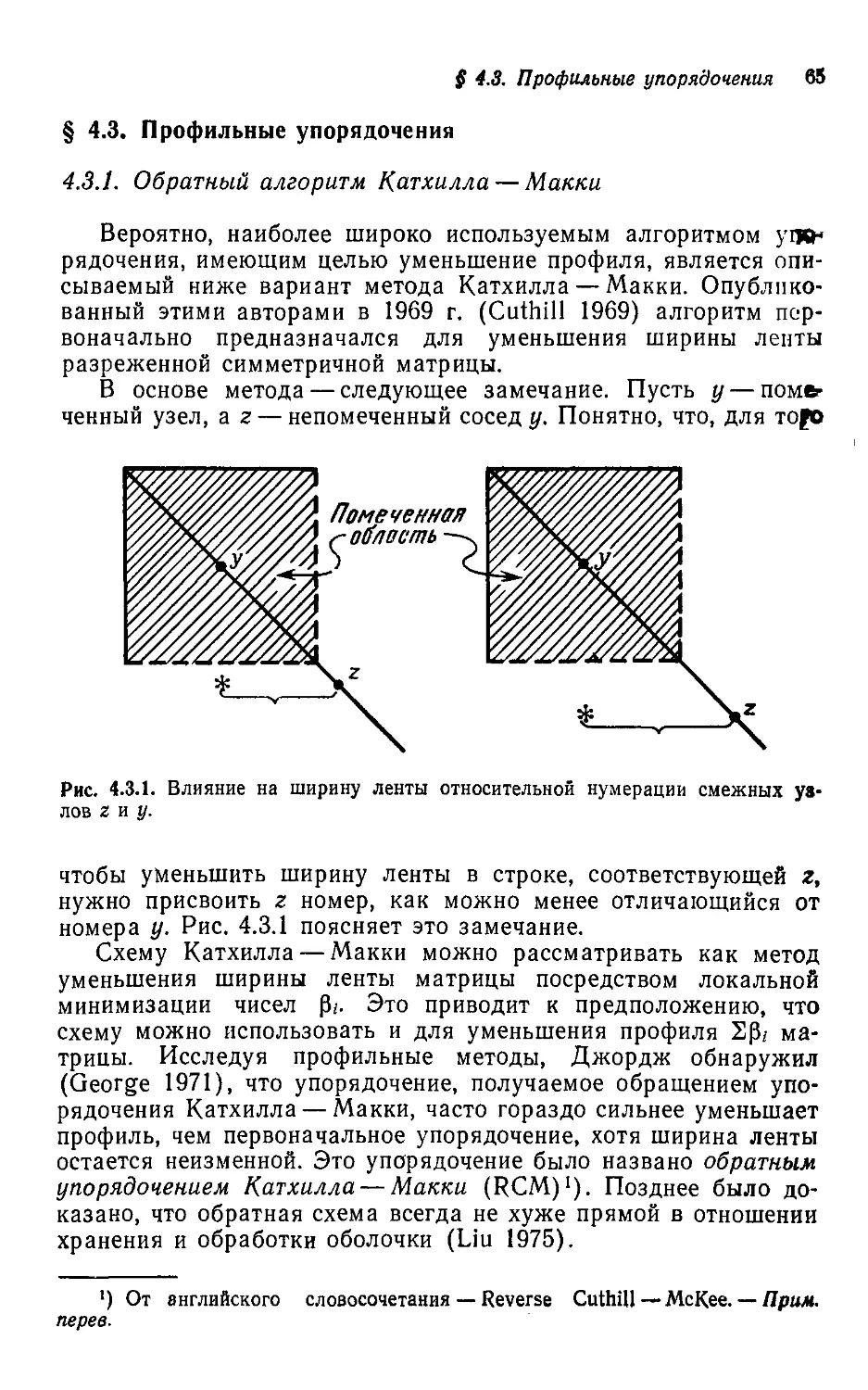

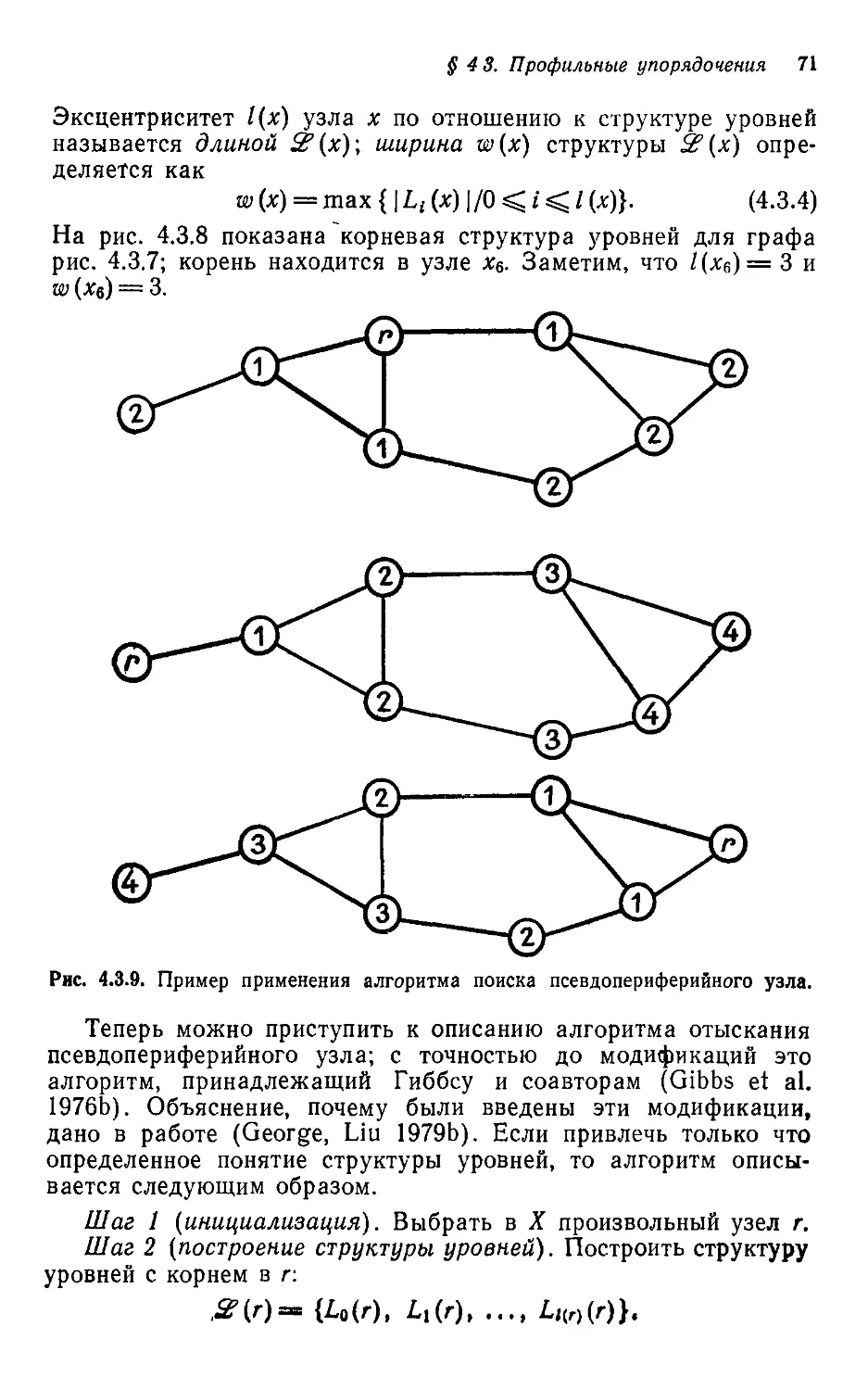

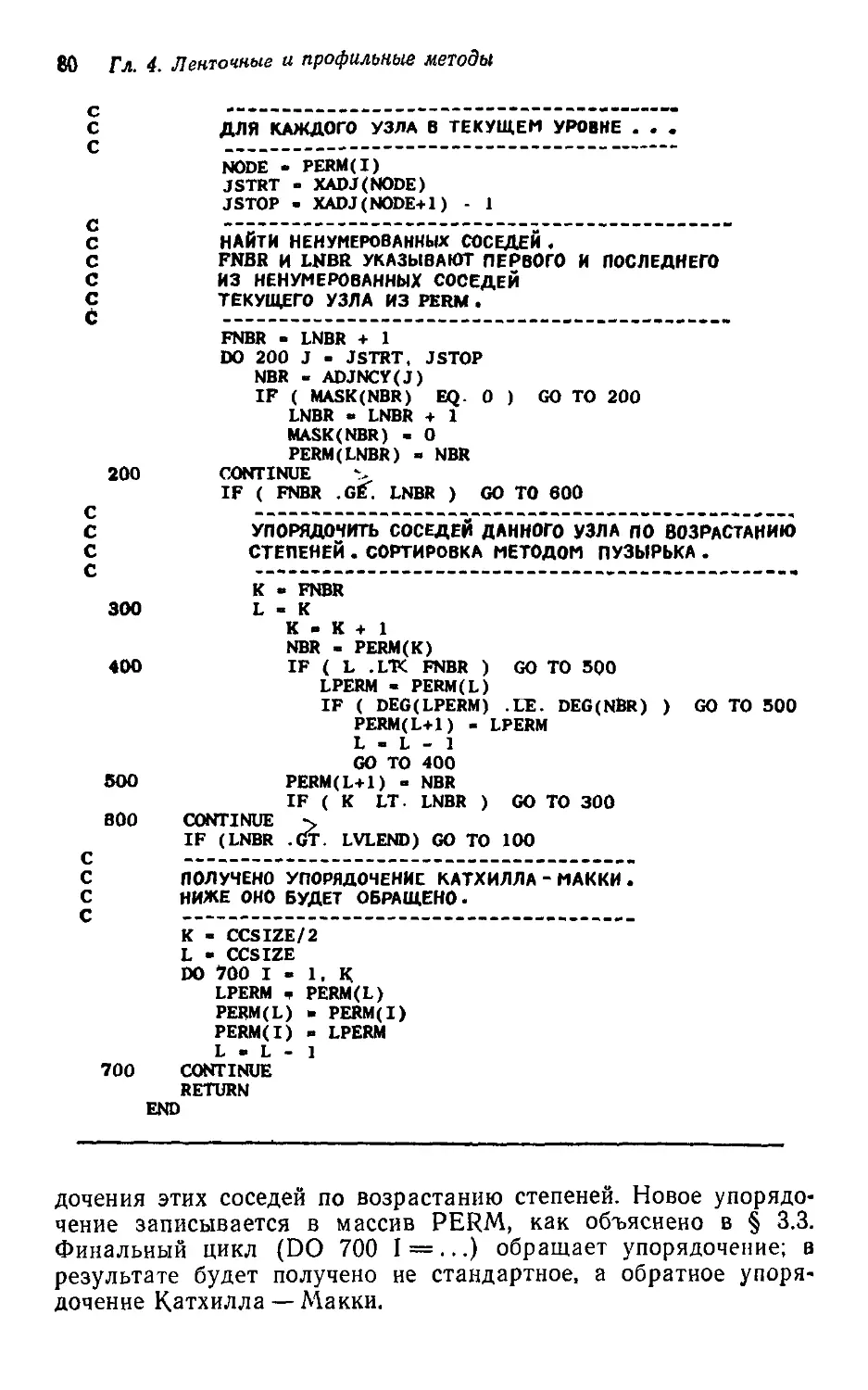

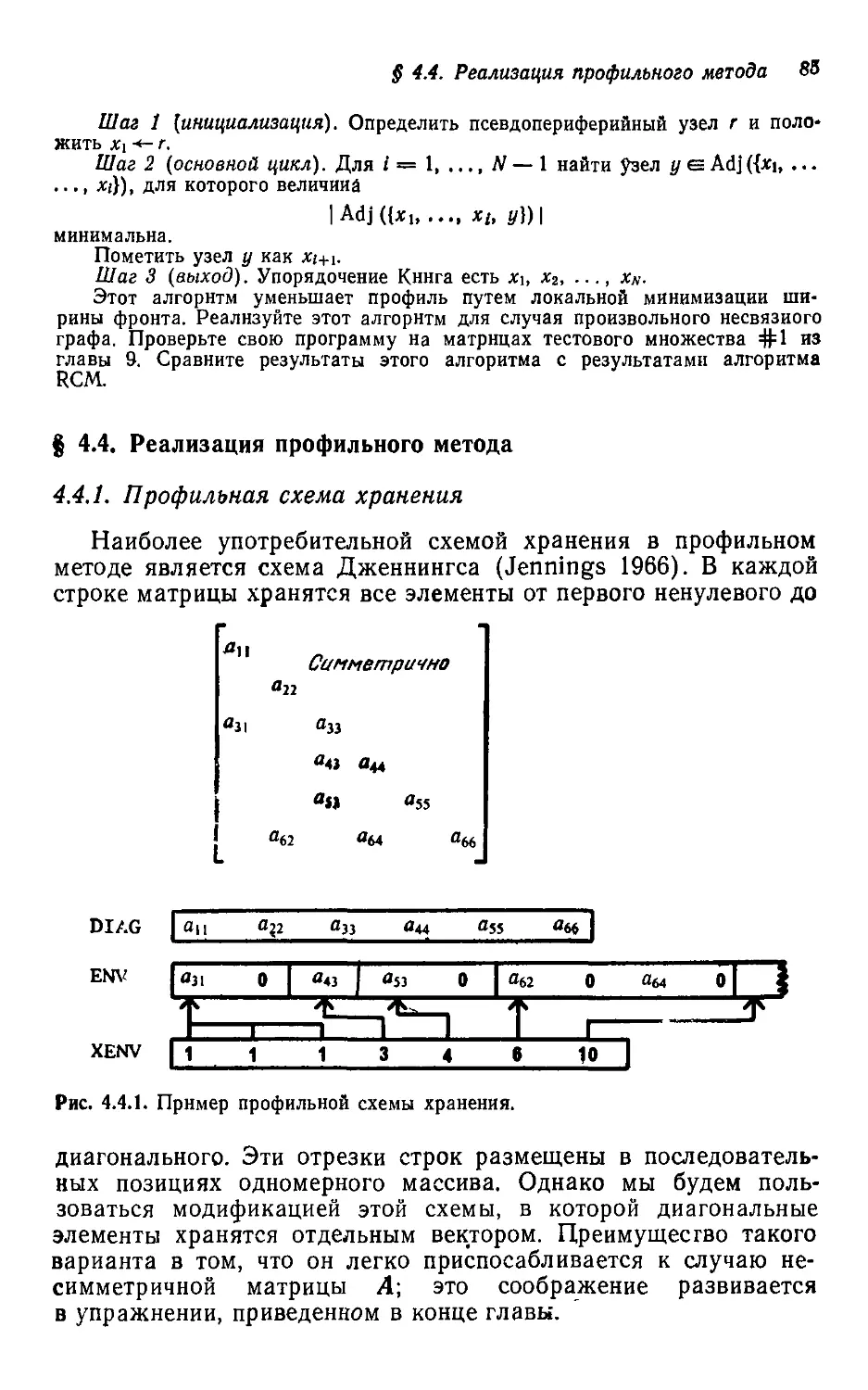

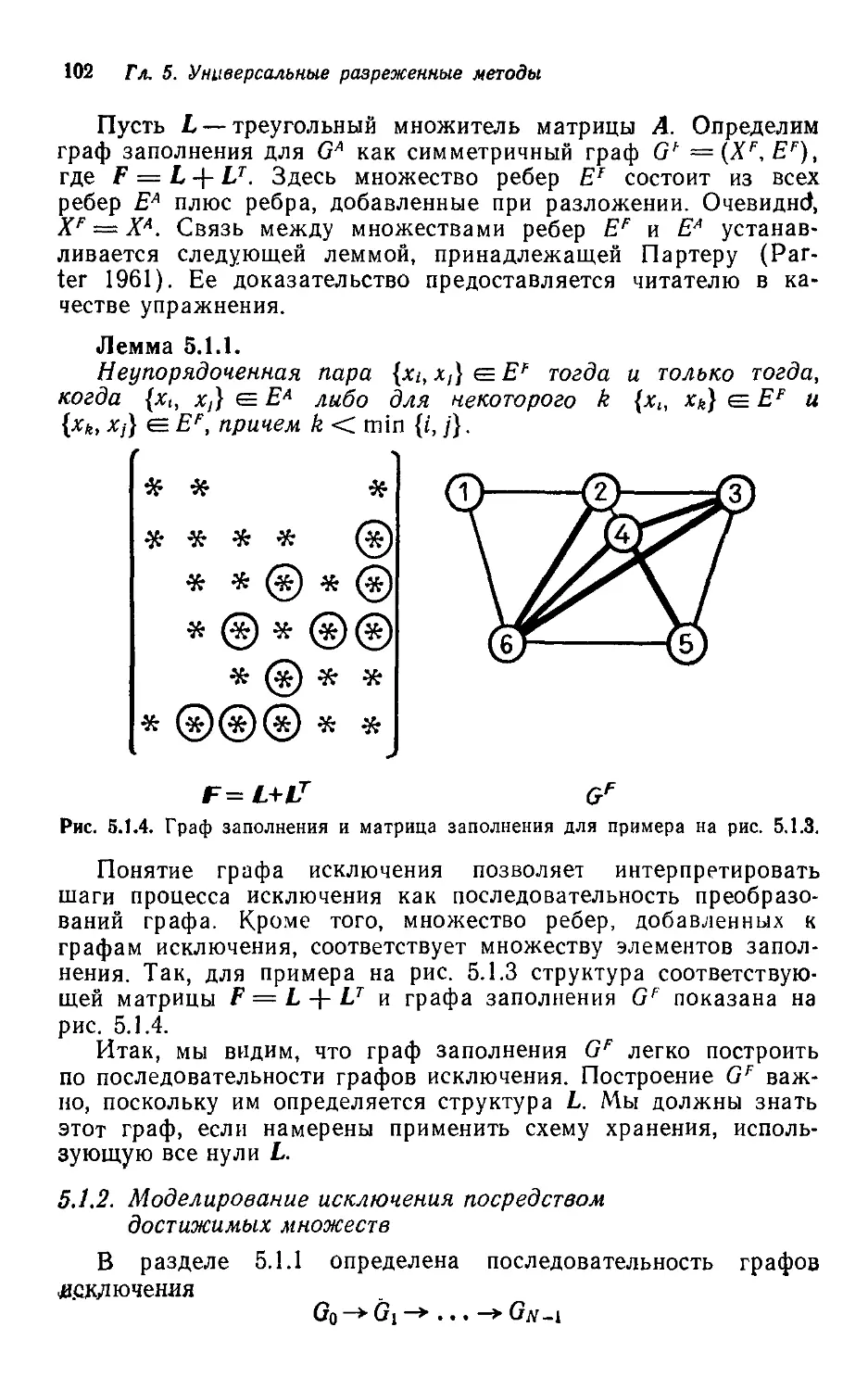

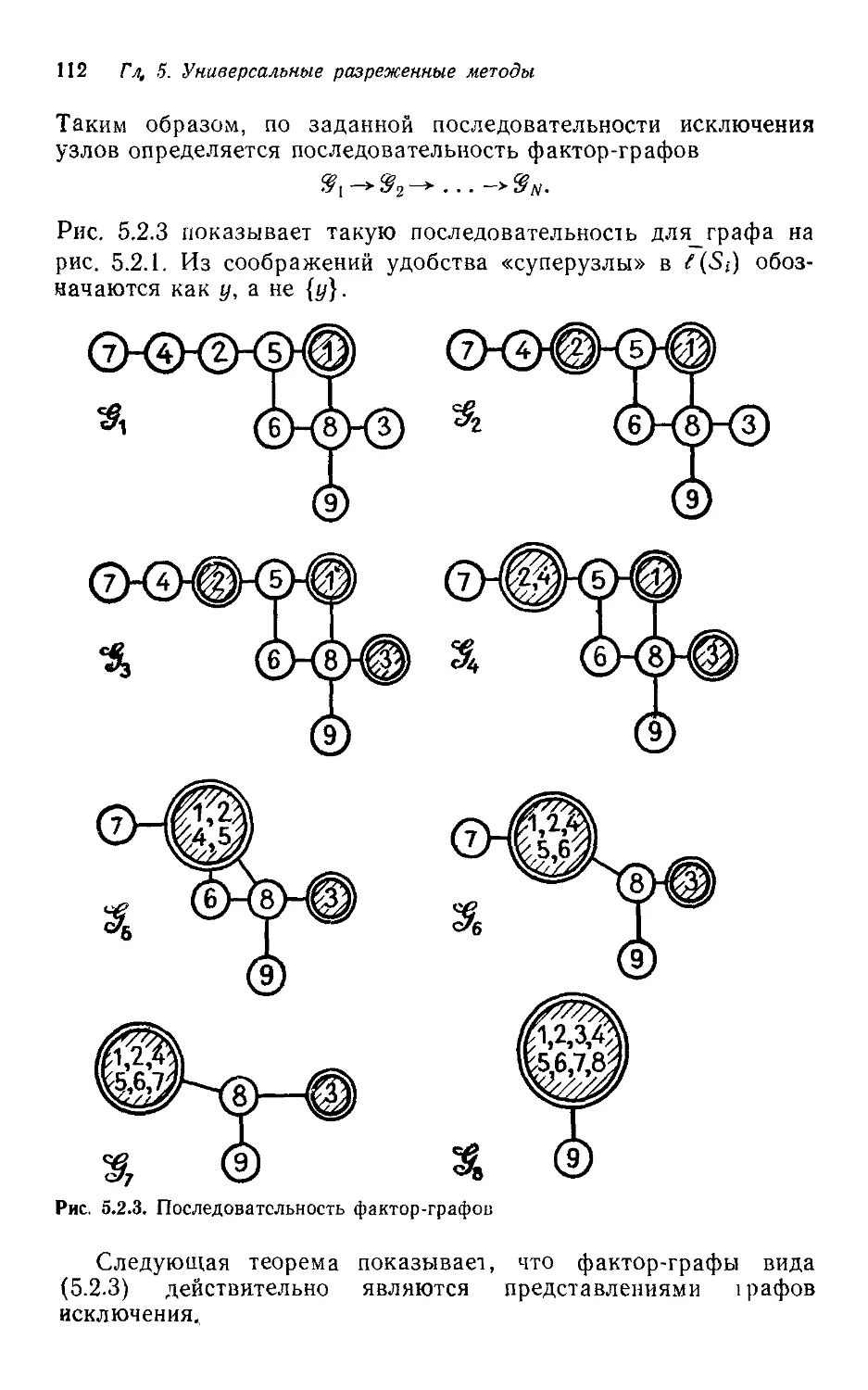

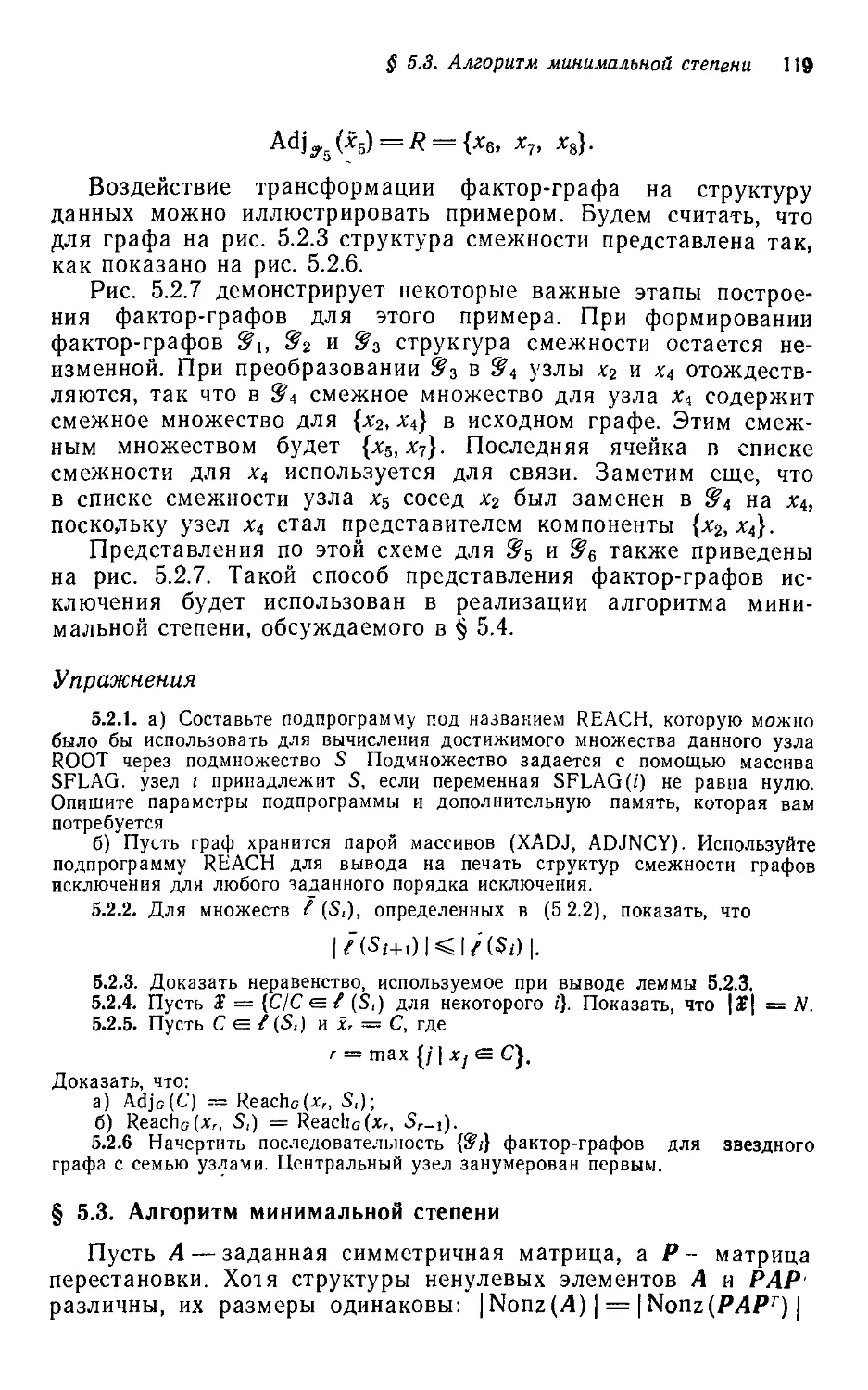

3.1.1. Симметричная матрица А называется разложимой, если найдется