Автор: Деннис Дж. Шнабель Р.

Теги: вычислительная математика численный анализ математика численные методы

ISBN: 5-03-001102-1

Год: 1988

Текст

Дж.Дэннис, Р.Шнабель

Численные методы

безусловной оптимизации

и решения нелинейных уравнений

/

Prentice-Hall Series in Computational Mathematics

Numerical Methods for Unconstrained Optimization

and Nonlinear Equations

J. E. Dennis, Jr.

Rice University

R. B. Schnabel

University of Colorado at Boulder

Prentice-Hall, Inc., Englewood Cliffs, New Jersey 07632

Дж. Дэннис, мл., Р. Шнабель

Численные методы

безусловной оптимизации

и решения

нелинейных уравнений

Перевод с английского

О. П. Бурдакова

под редакцией

Ю. Г. Евтушенко

Москва «Мир» 1988

ББК 22.193

Д94

УДК 519.61

Дэннис Дж., мл., Шнабель Р.

Д94 Численные методы безусловной оптимизации и решения

нелинейных уравнений: Пер. с англ. — М.: Мир, 1988. —

440 с, ил.

ISBN 5-03-001102-1

Монография известных американских специалистов, посвященная как теории

численных методов оптимизации, так и вопросам реализации этих методов на

ЭВМ. Особое внимание уделено наиболее эффективным методам ньютоновского

типа. Приведены пакеты программ решения прикладных задач оптимизации.

Для математиков-вычислителей, инженеров-исследователей, аспирантов и

студентов вузов.

Редакция литературы по математическим

наукам

ISBN 5-03-001102-1 (русск.) © 1983 by Prentice-Hall, Inc.

ISBN 0-13-627216-9 (англ.) © пеРевод на РУССКИЙ язйк* с ,оВоТо0р"

w**^ V'UU6 *1UJ \ап f скими исправлениями, «Мир», 19?§

Предисловие редактора перевода

и переводчика

Вниманию читателя предлагается книга американских

специалистов в области численного анализа Джона Дэнниса, мл., и

Роберта Шнабеля. Она посвящена двум важным и тесно

между собой связанным разделам: безусловной минимизации и

решению нелинейных уравнений. Наряду с серьезным

теоретическим материалом, отражающим современное состояние

исследований в рассматриваемой области, в книге большое

внимание уделяется вопросам программной реализации

численных методов и их преподавания в высшей школе.

Авторы сознательно ограничились рассмотрением

численных методов ньютоновского (квазиньютоновского) типа.

Класс этих методов отличает концептуальное единство и

достаточная широта охвата, причем на практике такие

методы—одни из наиболее эффективных. Общая идея методов

такова: на каждой итерации сначала строится модельная

аппроксимация исходной задачи (линейная в случае нелинейных

уравнений и квадратичная для безусловной минимизации), а

затем на основе ее решения находится новое приближение.

По такой же схеме проводится исследование сходимости.

Впервые столь подробно в литературе на русском языке

излагаются метод доверительной области, квазиньютоновские

методы типа секущих и др. Методы, не вошедшие в указанный

класс, в достаточной мере представлены ссылками на

литературу. В связи с тем что в оригинале имеется только одна

ссылка на работу советских авторов, мы решили указать несколько

отечественных монографий, содержащих обширные списки

литературы. Полагаем, что книга вполне пригодна для

формирования у читателя целостного представления о современном

состоянии численных методов минимизации и решения

нелинейных уравнений.

Более четверти книги занимают два приложения,

написанные Робертом Шнабелем. В отличие от несколько

схематичного описания алгоритмов в основной части цнрги, впрлне до-

6 Предисловие редактора перевода и переводчика

статочного для их теоретического рассмотрения, здесь

алгоритмы представлены уже с той степенью детализации,

которая требуется для их непосредственной программной

реализации. Они составляют в приложении А целостную систему

алгоритмов безусловной минимизации и решения нелинейных

уравнений. Эта система основана на модульном принципе,

ориентирована на учет особенностей машинной реализации и

хорошо документирована. При ее написании использован

условный алгоритмический язык, который вполне естественно

реализуется на Фортране, Алголе, Паскале, Си и других

языках программирования. Кстати, некоторые конструкции этого

псевдоязыка, описанного в разд. 1.3 приложения А, иногда

используются и в основной части книги. Приложение В

составляют тестовые задачи безусловной минимизации и

решения нелинейных уравнений. Как отмечали сами авторы,

любая большая система алгоритмов неизбежно содержит

опечатки и некоторые неточности. В этом авторы оказались, к

сожалению, правы. Вероятно, и мы окажемся правы, если

повторим это утверждение.

Несколько глав вводного характера делают книгу

доступной для тех, кто знаком лишь с основами математического

анализа и линейной алгебры. Изложение методически

продумано и сопровождается упражнениями. Имеются подробные

рекомендации по использованию книги в качестве учебного

пособия. При этом следует учитывать, что в США учебный

семестр длится 12—15 недель, а в неделю проводится 3

лекции, каждая около одного часа. Основная часть книги может

быть использована для чтения лекций студентам и

аспирантам, а упражнения — для проведения семинаров. Приложения

могут составить основу учебных проектов. Однако

возможности содержащейся в приложении А модульной системы

алгоритмов гораздо шире и позволяют создавать также пакеты

прикладных программ для решения практических задач.

В процессе работы над переводом возникали

всевозможные вопросы, породившие довольно интенсивную переписку с

авторами. Все исправления в книге сделаны либо с ведома

авторов, либо по их собственной инициативе. Мы выражаем

Дж. Дэннису и Р. Шнабелю глубокую признательность за

внимание к нашему труду.

Русскому изданию авторы предпослали посвящение «То

world peace», что можно перевести как «Делу мира во всем

мире». Они предложили подписаться под ним и нам, также

работавшим над книгой. Мы с радостью подписываем это

посвящение, отражающее искреннее стремление наших народов

к миру.

Ю. Г. Евтушенко

О. П. Бурдаков

Делу мира во всем мире

Дж. Дэннис, мл., Р. Шнабель,

О. Бурдаков, Ю. Евтушенко

Предисловие к русскому изданию

С большим удовольствием мы приветствуем издание этой

книги на русском языке. При ее написании мы стремились

к тому, чтобы она была полезной для студентов, научных

работников, а также для практиков, инженеров и всех тех, кто

использует методы оптимизации. На наш взгляд английский

вариант книги соответствует этим целям, и мы надеемся, что

русское издание окажется столь же полезным.

Хотя прошло уже четыре года со времени выхода в свет

первого издания на английском языке, книга на наш взгляд

практически не устарела. Основной материал книги по

безусловной минимизации и решению нелинейных уравнений, как

мы считали, стабилизировался в своем развитии в период ее

написания, и время, по-видимому, доказало правильность этой

оценки. Хотя исследования в этой области продолжались, мы

считаем, что за прошедшее время не произошло каких-либо

существенных изменений. Вероятно, наиболее важное

продвижение, о котором нам известно, заключалось в разработке

усложненных вариантов алгоритмов и программного

обеспечения для решения задачи «модель — доверительная область»

в случае, когда матрица Гессе не является знакоопределенной

(см., например, работы More, Sorensen [SIAM Journal on

Scientific and Statistical Computing 4, 1983J, Gay [SIAM

Journal on Scientific and Statistical Computing 2, 1981]), и

кроме того в широком развитии теории исследования таких

методов (см. также Shultz, Schnabel, Byrd [SIAM Journal on

Numerical Analysis 22, 1985]). Это привело к появлению

алгоритмов, которые обладают более сильными свойствами

глобальной сходимости по сравнению с приведенными в разд. 6.3.1,

и в которых удается избежать априорного возмущения незна-

коопределенных матриц Гессе в целях получения

положительно определенных матриц, как это делается в разд. 5.6. Еще

одним интересным достижением являются анализ и

вычислительный эксперимент, проведенные в недавних работах Powell

8 Предисловие к русскому изданию

[Mathematical Programming 34, 1986] и Byrd, Nocedal, Yuan

[SIAM Journal on Numerical Analysis, 1987J, которые дают

более удачное объяснение превосходству положительно

определенной формулы секущих (BFGS) над обратной положительно

определенной формулой секущих (DFP) при решении задач

безусловной оптимизации. Были достигнуты успехи также и в

некоторых непосредственно примыкающих областях, включая

глобальную оптимизацию, методы решения задач большой

размерности со специальной структурой и методы для решения

задач безусловной оптимизации и систем нелинейных

уравнений на параллельных ЭВМ.

Приведенное в приложении программное обеспечение

получило широкое распространение и было включено в другие

пакеты программ, книги-и библиотеки математического

программного обеспечения. Мы по-прежнему предоставляем это

программное обеспечение в распоряжение научных работников для

использования в исследовательских целях.

Нам хочется выразить особую благодарность О. Бурдакову

за превосходно выполненную работу по переводу. Стремясь как

можно точнее перевести книгу, он изучил ее столь тщательно,

что выявил большое количество опечаток и неточностей. Мы

признательны ему за этот вклад в укрепление международных

научных связей.

Дж. Дэннис, мл.

Р. Шнабель

Май 1987

Предисловие

Книга представляет собой подробное введение в численное

решение задач безусловной оптимизации и систем нелинейных

уравнений, не требующее от читателя глубоких знаний

математических и вычислительных дисциплин. Работа над книгой

была начата в 1977 г., поскольку мы считали, что к этому

времени алгоритмы и теория решения таких задач малой и

средней размерности достигли зрелого состояния и что был бы

полезен подробный справочный материал. Книгу можно

использовать при подготовке курса лекций для аспирантов или

студентов-старшекурсников, а также ее можно рекомендовать

для самостоятельного изучения научным работникам,

инженерам и всем, кому рассматриваемые задачи интересны с

практической точки зрения.

Минимальная подготовка, необходимая для чтения книги,—

это знание основ математического анализа и линейной алгебры.

Читатель, должно быть, в той или иной мере знаком с

математическим анализом многих переменных, тем не менее в гл. 4

приводится подробный обзор всей необходимой информации.

Несомненную пользу мог бы принести курс

вычислительной линейной алгебры или элементов численных методов;

часть этого материала кратко представлена в разд. 1.3 и

гл. 3.

Все рассматриваемые здесь алгоритмы основываются на

идее метода Ньютона. Они часто называются методами

ньютоновского типа, однако мы предпочитаем термин

квазиньютоновские методы. К сожалению, этот термин используется

специалистами лишь для подкласса методов, представленного

гл. 8 и 9. Поскольку этот подкласс состоит из естественных

обобщений метода секущих на многомерный случай, мы

предпочитаем называть их методами секущих. Конкретные

варианты методов секущих обычно носят имена своих создателей,

поэтому в тексте неизбежно встречаются соответствующие не

всегда понятные аббревиатуры. Вместе с тем мы пытались

1 0 Предисловие

предложить для них содержательные названия, отвечающие

их месту в общей схеме изложения.

Ядро книги составляет материал по численным методам

решения многомерных задач безусловной оптимизации и

нелинейных уравнений. Он представлен гл. 5—9. Глава 1 —

вводная, она принесет больше пользы студентам,

специализирующимся в чистой математике и информатике, чем читателям,

имеющим некоторый опыт в научных приложениях. Глава 2,

которая посвящена одномерному варианту рассматриваемых

задач, является иллюстрацией нашего подхода и одновременно

его обоснованием. Глава 3 может быть пропущена читателями,

уже изучавшими вычислительную линейную алгебру, а гл. 4 —

теми, кто обладает основательными познаниями в

математическом анализе многих переменных. Глава 10 дает довольно

полное изложение алгоритмов решения нелинейной задачи о

наименьших квадратах, которая относится к важному классу

задач безусловной оптимизации и из-за ее специфики решается

специальными методами. В ней существенно используется

материал предыдущих глав. В гл. 11 указываются некоторые

перспективные направления исследований; здесь отдельные

разделы сложнее, чем предыдущий материал.

Мы использовали эту книгу в учебных курсах для

старшекурсников и аспирантов. Для первых из них гл. 1—9 образуют

фундаментальный курс, а для последних может быть

использована вся книга целиком. При этом если гл. 1, 3 и 4 оставить

для самостоятельного чтения, то курс займет около половины

семестра. Оставшуюся часть семестра легко заполнить

указанными главами или другим материалом, не вошедшим в книгу.

Наибольшую важность среди опущенного нами материала

представляют методы, не связанные с методом Ньютона для

решения задач безусловной минимизации и нелинейных

уравнений. Большинство из них важны только в частных случаях.

Симплексный алгоритм Нелдера — Мида !> [см., например, Ав-

риель (1976)], эффективный для задач с менее чем пятью

переменными, может быть изложен за час. Методы сопряженных

направлений [см., например, Гилл, Мюррей и Райт (1981)]

относятся собственно к курсу вычислительной линейной

алгебры, но благодаря малому объему требуемой памяти ЭВМ они

оказываются полезными и для задач оптимизации с очень

большим числом переменных. Их можно вкратце изложить за

два часа, полное же изложение заняло бы две недели.

Наиболее трудным для нас было решение опустить методы

Брауна — Брента. Их идея изящна и они поразительно

эффективны при хороших начальных приближениях для решения си-

!) Он также известен под названием «алгоритм (демпфируемого)

многогранника» — Прим. перев.

Предисловие ff

стем уравнений, часть из которых линейны. Этим методам в

наиболее распространенной форме нельзя отдать безусловное

предпочтение в задачах общего вида. Они вряд ли где-либо

освещались так же широко, как симплексный алгоритм и

алгоритм сопряженных градиентов. Отсутствие этих методов

можно восполнить одной или двумя лекциями (опуская

доказательства) (см., например, Дэннис (1977)]. Наконец, среди

методов, имеющих важное значение, не нашли отражения

методы типа продолжения или гомотопии, работы по которым

возобновились с новой силой в 70-х гг. Эти изящные идеи

могут пригодиться как крайнее средство в исключительно

трудных задачах, хотя в целом они все же не конкурентоспособны.

На изложение превосходного обзора Алговера и Джорджа

(1980) потребуется по крайней мере две недели.

Книга снабжена большим количеством упражнений, многие

из которых содержат дальнейшее развитие идей, лишь слегка

затронутых в тексте. Большое приложение, написанное Р. Шна-

белем, имеет целью обеспечить как основами для учебных

проектов, так и важным справочным материалом для тех

читателей, кто хочет вникнуть в детали алгоритмов и, возможно,

разработать свои собственные версии. Рекомендуем читателю

на раннем -этапе чтения ознакомиться с предисловием к

приложению.

Некоторые вопросы терминологии и обозначения вызвали

особенные трудности. Ранее уже упоминалось о смешении

понятий «квазиньютоновские методы» и «методы секущих».

Кроме того, в заглавии книги мы использовали термин

«безусловная оптимизация», а в тексте — «безусловная минимизация»,

поскольку в действительности рассматривается только

минимизация, а задача максимизации очевидным образом сводится

к минимизации. Важный термин «глобальный» часто

интерпретируется по-разному, поэтому в разд. 1.1 пояснено, как

именно он понимается в книге. Наконец, основная проблема в

обозначениях состояла в том, чтобы различать между собой

/-ю компоненту л-мерного вектора (скаляр, обычно

обозначаемый как xi) и i-ю итерацию в последовательности таких

векторов х (вектор, также обычно обозначаемый как *,•). После

нескольких неудачных попыток было решено допустить эту

неоднозначность в обозначениях, поскольку подразумеваемый

смысл всегда понятен из контекста. В действительности это

обозначение редко используется в обоих смыслах в одном и

том же разделе.

Нам хотелось без ущерба для изложения сделать книгу

настолько краткой и недорогой, насколько это возможно. Исходя

из этого, безжалостно редактировались некоторые

доказательства и целые темы. Мы старались использовать обозначения,

отвечающие тонкому вкусу и одновременно лучшему понима-

12 Предисловие

нию, и включать доказательства, способствующие хорошему

усвоению предмета, опуская те, которые всего лишь

устанавливают справедливость утверждений. Мы ожидаем больше

критики в отношении того, что было опущено, нежели в

отношении того, что включено. Однако, как известно каждому

преподавателю, наиболее трудной и важной частью составления

учебного курса является решение о том, что следует опустить.

Мы искренне благодарим Идалию Келлар, Арлин Хантер

и Долорес Пендел за перепечатку многочисленных вариантов

рукописи, а также студентов за их поразительную способность

отыскивать неясные места. Дэвид Гэй, Вирджиния Клема, Хо-

мер Уолкер, Пит Стюарт и Лэйн Уотсон использовали

черновой вариант книги в курсах лекций в Массачусетском

технологическом институте, Лоренцевской лаборатории Ливермора,

Университете Хьюстона, Университете Нью-Мексико,

Университете Мериленд и Вирджинском политехническом институте и

внесли полезные предложения. Тронд Стейхауг и Майк Тодд

высказали ряд удачных замечаний по некоторым разделам.

Дж. Дэннис, мл.

Райсовский университет

Р. Шнабель

Университет Колорадо

в Боулдере

Прежде всего одно программное замечание

В первых четырех главах книги содержатся вводные сведения и излагаются

побудительные мотивы к исследованию многомерных нелинейных задач.

В гл. 1 вводятся задачи, которые будут обсуждаться в дальнейшем. Затем в

гл. 2 приводятся некоторые алгоритмы решения нелинейных задач только

одной переменной. Излагая эти алгоритмы так, чтобы отразить основные

идеи всех рассматриваемых далее в книге нелинейных алгоритмов, мы

надеемся тем самым обеспечить читателя доступным и прочным фундаментом

для исследования многомерных нелинейных задач. В гл. 3 и 4 содержится

материал по основам вычислительной линейной алгебры и многомерного

анализа, необходимый для перехода к задачам более чем одной переменной.

1

Введение

В книге приводятся и анализируются методы и алгоритмы

численного решения трех важных нелинейных задач: решение

систем нелинейных уравнений, безусловная минимизация

нелинейного функционала и задача оценки параметров по

нелинейному принципу наименьших квадратов. В разд. 1.1 даются

постановки этих задач и предположения, в рамках которых они

в дальнейшем будут рассматриваться. В разд. 1.2 приводятся

примеры нелинейных задач и обсуждаются характерные

особенности задач, встречающихся на практике. Читатель, уже

знакомый с кругом таких задач, может при желании

пропустить этот раздел. В разд. 1.3 резюмируются особенности

машинной арифметики конечной точности, которые необходимо

знать читателю для понимания машинно-зависимых элементов

обсуждаемых в тексте алгоритмов.

1.1. ПОСТАНОВКИ ЗАДАЧ

В настоящей книге рассматриваются три часто встречающиеся

на практике нелинейные задачи с действительными

переменными. Хотя при довольно естественных предположениях они

с математической точки зрения эквивалентны, мы не будем

применять для всех них одни и те же алгоритмы. Вместо этого

будет продемонстрирована способность наилучших среди

имеющихся в настоящее время алгоритмов учитывать специфику

каждой задачи.

Среди трех задач, с которыми мы будем иметь дело,

решение систем нелинейных уравнений, называемых далее

«нелинейными уравнениями», является самой основной. Вместе с

тем она имеет меньше всего специфических особенностей,

учитываемых в алгоритмах. Задача состоит в следующем:

задано: F:Rn->Rn,

найти ^sR", для которого F (*J = 0 <= R", (1.1.1)

1.1. Постановки задач 15

где Rn обозначает n-мерное евклидово пространство.

Представление (1.1.1) есть один из стандартных способов задания

системы из п уравнений с п неизвестными, при котором правая

часть каждого уравнения полагается равной нулю. Примером

служит

где F (*,,) = 0 при *» = (1,— 2)г.

Несомненно, что х*> являющееся решением (1.1.1), будет

точкой минимума для

t(fi(x))\

где fi(x) обозначает i-ю компоненту функции F. Это частный

случай задачи безусловной минимизации:

задано: /:R*-*R,

найти Jt.eR'1, для которого f(xm)^.f(x) при всех x^Rn.

(1.1.2)

Это вторая из рассматриваемых далее задач. Обычно (1.1.2)

кратко записывается как

min/:R"-*R. (1.1.3)

Примером служит

min / (хи хъ *3) = (*1 - З)2 + (х2 + 5)4 + (х3 - 8)2,

x<=Rn

где решение есть jc# = (3, —5, 8)г.

В некоторых приложениях представляет интерес задача

(1.1.3) с ограничениями

min /:R"->R, (1.1.4)

где Q — замкнутая связная область. Если решение задачи

(1.1.4) лежит внутри Q, то (1.1.4) еще можно считать

задачей безусловной минимизации. Но если л:*—граничная точка

области Q, то минимизация / на Q становится задачей

условной минимизации. Эта задача рассматриваться не будет

потому, что способы ее решения менее изучены, чем в задаче

безусловной минимизации, а, имея дело с последней, нам и

без того есть чем заняться. К тому же техника решения задач

без ограничений служит основой для алгоритмов решения

задач с ограничениями. Многие подходы к решению задачи с

ограничениями фактически сводятся либо к решению некото-

16 Гл. 1. Введение

рой родственной ей задачи безусловной минимизации, чье

решение х по крайней мере очень близко к решению х* задачи

с ограничениями, либо к построению системы нелинейных

уравнений, решение которой совпадает с х+. Наконец, большой

процент задач, которые встречались нам на практике, суть задачи

или без ограничений или же с ограничениями, но очень

простого вида (к примеру: каждая компонента х должна быть

неотрицательной).

Третья из рассматриваемых задач также является частным

случаем безусловной минимизации, но из-за ее важности и

специфичной структуры, она представляет самостоятельный

интерес для исследования. Это нелинейная задача о

наименьших квадратах:

задано: R: Rn -> Rm, m > n,

m

найти x0 e R", для^которого £ (rt (x))2 минимально, (1.1.5)

где через ri(x) обозначена /-я компонента функции R. Задача

(1.1.5) наиболее часто встречается при проведении кривой по

точкам. Она также может возникать всякий раз, когда в

нелинейной системе количество нелинейных связей превосходит

число степеней свободы.

Мы будем иметь дело исключительно с тем весьма общим

случаем, когда нелинейные функции F, f и R

дифференцируемы соответственно один раз, дважды и дважды непрерывно.

При этом нет необходимости предполагать, что имеются

аналитически заданные производные, а всего лишь, что функции

достаточно гладки. Дальнейшие замечания относительно

характерных размеров и других характеристик решаемых на

сегодняшний день делинейных задач можно найти в разд. 1.2.

Весьма типичным при численном решении нелинейной

задачи является такой сценарий. Пользователя просят задать

процедуру для вычисления функции (функций),

фигурирующей в постановке задачи, и начальную точку *0, т. е. грубое

приближение к решению х*. Если это не вызывает особых

трудностей, то пользователя просят задать первые и,

возможно, вторые производные. В книге особый акцент делается на

трудностях, наиболее часто встречающихся при решении

задач. Они укладываются в рамки следующих вопросов: (1) что

делать, если начальное приближение хо не близко к решению х+

(«глобальный метод»), и как это эффективно сочетать с

методом, использующимся вблизи от решения («локальный

метод»); (2) что делать, если в нашем распоряжении нет

аналитически заданных производных; (3) разработка алгоритмов.

эффективных в тех случаях, когда вычисление функции

(функций), определяющей задачу, стоит дорого (часто это именно

1.1. Постановки задач 17

так, причем стоимость порой становится критическим

фактором). Будут рассмотрены основные методы и описаны детали

алгоритмов, являющихся в настоящее время наилучшими для

решения таких задач. Будет также дан анализ того, что, по

нашему убеждению, имеет непосредственное отношение к

пониманию этих методов и к возможности их дальнейшего

обобщения и улучшения. В частности, мы попытаемся выделить,

специально заострив на них внимание, идеи и методы,

которые в результате их развития заняли центральное место в

данной области. На наш взгляд, эта область достигла состояния,

когда упомянутые методы легко выделяемы, и хотя все же

возможны некоторые усовершенствования, в будущем не

следует ожидать новых алгоритмов, которые привели бы к

заметному скачку вперед по сравнению с теми, что считаются

на сегодня наилучшими.

Методы решения нелинейных уравнений и задач

безусловной минимизации тесно связаны. Большая часть книги

посвящена этим двум задачам. Нелинейная задача о наименьших

квадратах есть всего лишь частный случай безусловной

минимизации, однако можно так модифицировать методы

безусловной минимизации, учитывая преимущества специфики

нелинейной задачи о наименьших квадратах, что для нее в

результате получатся более эффективные алгоритмы. Таким

образом, гл. 10 в действительности является развернутым

иллюстративным примером, демонстрирующим то, как

применять и обобщать предшествующий этому материал книги.

Одна задача, к которой мы не обращаемся в книге,

заключается в нахождении «глобального минимума» нелинейной

функции, иными словами, самого наименьшего значения f(x)

в случае, когда имеется много изолированных локальных

минимумов, т. е. решений задачи (1.1.2) в открытых связных

областях пространства Rn. Это очень сложная задача, о которой

нельзя сказать, что она так же широко изучена и успешно

решается, как и рассматриваемые нами задачи. Данной теме

посвящены два сборника статей под ред. Диксона и Сегё

(1975, 1978). На протяжении всей книги используется термин

«глобальный», например в сочетаниях «глобальный метод» или

«глобально сходящийся алгоритм», для обозначений метода,

в котором обеспечивается сходимость к локальному минимуму

нелинейной функции или к некоторому решению системы

нелинейных уравнений почти из любой начальной точки. Было бы

видимо удачнее называть такие методы локальными или

локально сходящимися, однако, согласно традиции, эти термины

уже зарезервированы для использования в другом смысле.

Любой метод, для которого гарантируется сходимость из любой

начальной точки, вероятно, в общем случае весьма

неэффективен [см. работу Алговера и Джорджа (1980)].

18 Гл. 1. Введение

1.2. ХАРАКТЕРНЫЕ ОСОБЕННОСТИ ВСТРЕЧАЮЩИХСЯ

НА ПРАКТИКЕ ЗАДАЧ

В этом разделе мы попытаемся дать некоторое представление

о нелинейных задачах, встречающихся на практике. Сначала

будут приведены три реальных примера нелинейных задач и

некоторые соображения относительно их постановки как

вычислительных задач. Затем будет сделано несколько замечаний

по поводу размера, стоимости и других характеристик обычно

встречающихся нелинейных задач.

Обсуждение модельных задач затруднено тем, что

происхождение и алгебраическое описание задач из этой области

редко оказываются простыми. Хотя все это довольно интересно,

но не для вводной главы книги по численному анализу.

Поэтому наши примеры будут по мере возможности упрощены.

Наиболее простыми среди нелинейных задач являются

задачи с одной переменной. Например, исследователь хочет

определить молекулярную конфигурацию некоторого соединения.

Он выводит выражение f(x), задающее потенциальную

энергию возможной конфигурации как функцию переменной х,

представляющей собой тангенс угла между ее двумя

компонентами. Затем, поскольку природа заставит молекулу принять

конфигурацию с минимальной потенциальной энергией,

желательно найти такое лг, для которого f(x) минимально. Это

задача минимизации с единственной переменной х. Из

физического смысла функции / ясно, что она сильно нелинейна. Верно

и то, что она является задачей безусловной минимизации, так

как х может принимать любое действительное значение.

Поскольку эта задача имеет только одну переменную, она

должна бы легко решаться методами из гл. 2. Однако мы

сталкивались с аналогичными задачами, в которых f была функцией

от 20 до 100 переменных, и хотя эти задачи не были трудными

для решения, но каждое вычисление / стоило от 5 до 100 долл.,

так что они оказались дорогостоящими для решения.

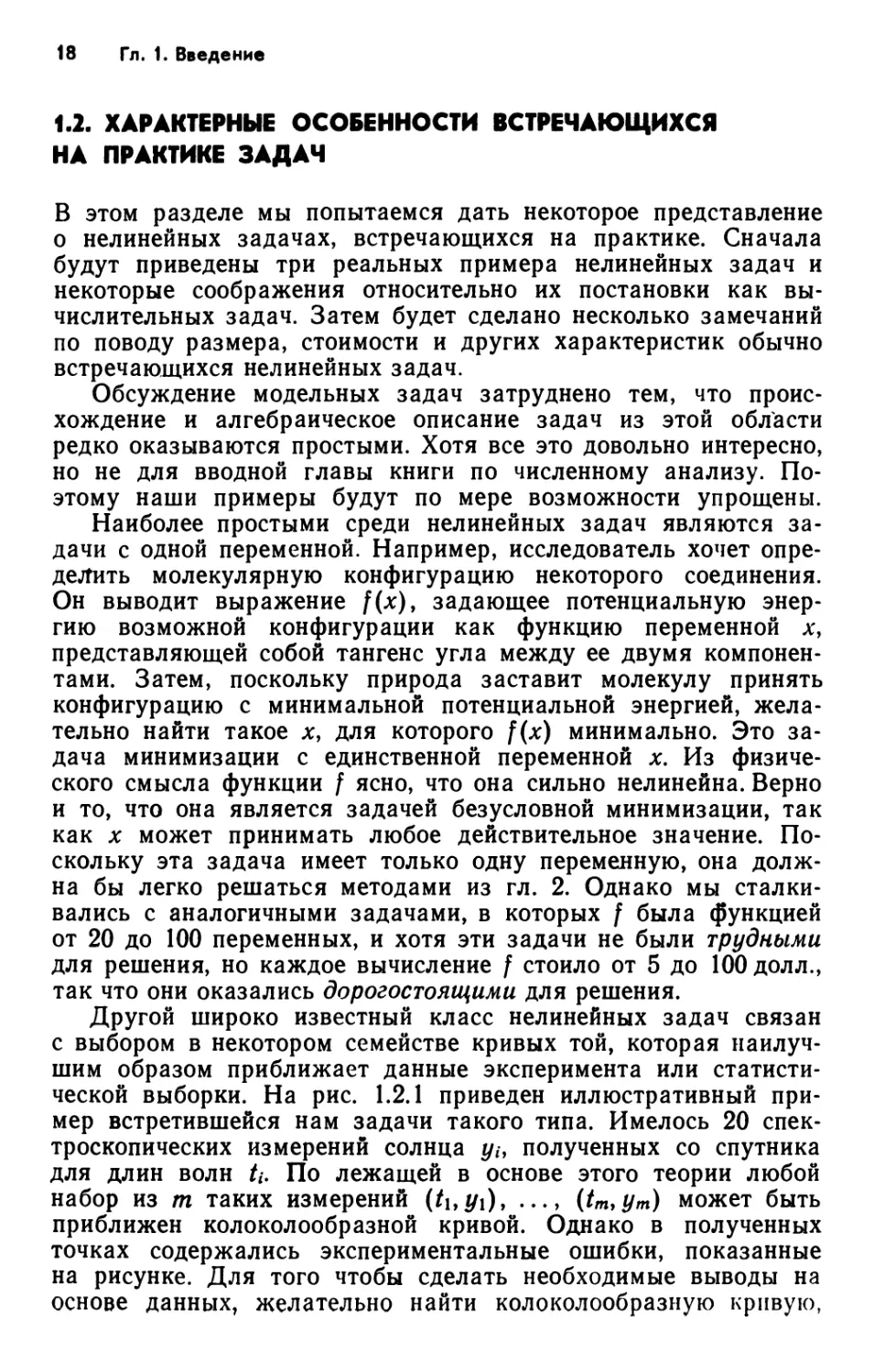

Другой широко известный класс нелинейных задач связан

с выбором в некотором семействе кривых той, которая

наилучшим образом приближает данные эксперимента или

статистической выборки. На рис. 1.2.1 приведен иллюстративный

пример встретившейся нам задачи такого типа. Имелось 20

спектроскопических измерений солнца yif полученных со спутника

для длин волн U. По лежащей в основе этого теории любой

набор из m таких измерений (/i,#i), ..., (tm,ym) может быть

приближен колоколообразной кривой. Однако в полученных

точках содержались экспериментальные ошибки, показанные

на рисунке. Для того чтобы сделать необходимые выводы на

основе данных, желательно найти колоколообразную кривую,

1.2. Характерные особенности задач 19

«наиболее близкую» к т точкам. Поскольку колоколообразная

кривая в общем виде описывается формулой

У{ХЬ *2> Х3, *4, 0 = *1+*2е~('+*з)2/*>

это означает, что Х\У Х2, *з и х\ выбираются так, чтобы

минимизировать некоторую совокупную меру расхождений

(невязок) между точками данных и кривой. Невязки даются

формулой

П(х)Ау(хи *ъ *з. х*> t^ — yt.

В качестве совокупной меры наиболее часто используется

сумма квадратов величин г/, что приводит к определению колоко-

лообразной кривой путем решения нелинейной задачи о

наименьших квадратах:

т т

min / (х) A Z П (х)2= £ h + x2e-(fi+x*Wx* - yt\\ (1.2.1)

xeR'

i~\

i=\

Здесь уместны следующие замечания. Во-первых, причина,

по которой задача (1.2.1) называется нелинейной задачей

о наименьших квадратах, состоит в том, что невязки п(х)

являются нелинейными функциями некоторых из переменных х\,

*2, *э, *4. Фактически п линейны по хх и лег, и некоторые

современные методы используют такую специфику (см. гл. 10). Во-

вторых, существуют функции, иные нежели сумма квадратов,

которые можно выбирать для определения меры отклонения

данных точек от колоколообразной кривой. Два очевидных

выбора суть

т

M*)=£lM*)i

fOQ(x)= max \п(х)\.

J L

J L_

*i h t5

Рис. 1.2.1. Точки данных, которые требуется «наилучшим образом приблизить

колоколообразной кривой.

20 Гл. 1. Введение

Соображения, по которым для минимизации обычно

выбирается /(лс), а не f\(x) или foo(x), иногда связаны со

статистической интерпретацией, а иногда с тем, что получающаяся

задача оптимизации гораздо лучше поддается математическому

анализу, так как сумма квадратов в отличие от двух других

функций непрерывно дифференцируема. На практике

большинство задач о наилучшем приближении данных решается с

использованием принципа наименьших квадратов. Часто /

модифицируется введением «весов» при невязках, однако это не

существенно для наших дальнейших рассуждений.

В качестве последнего примера рассмотрим некоторый

вариант задачи, встретившейся при изучении термоядерного

реактора. Термоядерный реактор можно представить себе

в виде тороидальной камеры с разогретой плазмой внутри

(рис. 1.2.2). Реальная задача в упрощенном (ради

наглядности) виде заключается в нахождении такого сочетания радиуса

тора г, его ширины w и температуры плазмы /, которое

приводило бы к наименьшей стоимости единицы вырабатываемой

энергии. Специалисты установили, что стоимость единицы

энергии моделируется выражением

+ C»(i+'S')<101""'',,• <'-2-2>

где c\t С2, с3, с4—константы. Таким образом, задача состояла

в минимизации / как функции от г, w и /.

Однако имелись и другие важные аспекты задачи. Прежде

всего г, w и t в отличие от переменных из предыдущих

примеров не могли принимать произвольные действительные

значения. Например, г и w не могли быть отрицательными.

Следовательно, это задача условной минимизации. Всего было

пять простых линейных ограничений на три переменные.

/ / г

Температура^)^" Г [ f

Рис. 1.2.2. Термоядерный реактор.

1.2. Характерные особенности задач 21

Важно подчеркнуть, что задача с ограничениями должна

рассматриваться как задача условной оптимизации только

тогда, когда наличие ограничений может повлиять на

получающееся решение, т. е. когда ожидается, что решение задачи

с ограничениями не совпадет с точкой минимума той же самой

функции без ограничений. В задаче о термоядерном реакторе

наличие ограничений обычно имело существенное значение, и

поэтому задача решалась методами, учитывающими

ограничения. Однако многие задачи с простыми ограничениями,

такими, как ограничения снизу и сверху на переменные, можно

решать алгоритмами безусловной минимизации, поскольку

ограничения удовлетворяются в точке безусловного минимума.

Отметим, что, как было написано, ограничения в задаче

о термоядерном реакторе обычно влияли на решение. Это

объясняется тбм, что требовалось решить 625 вариантов задачи,

отвечающих различным значениям констант сь с2> £з и с*.

Значения этих констант зависят от таких факторов, как, например,

стоимость электроэнергии, которая будет постоянной во время

эксплуатации реактора, но которая заранее не известна. Было

необходимо просчитать различные варианты задачи для того,

чтобы увидеть, как изменение этих факторов влияет на

оптимальные характеристики реактора. Часто в практических

приложениях желательно решить много связанных между собой

вариантов задачи. Это повышает требования к эффективности

алгоритма, а также вынуждает проводить предварительные

эксперименты с различными алгоритмами для оценки их

эффективности на данном классе задач.

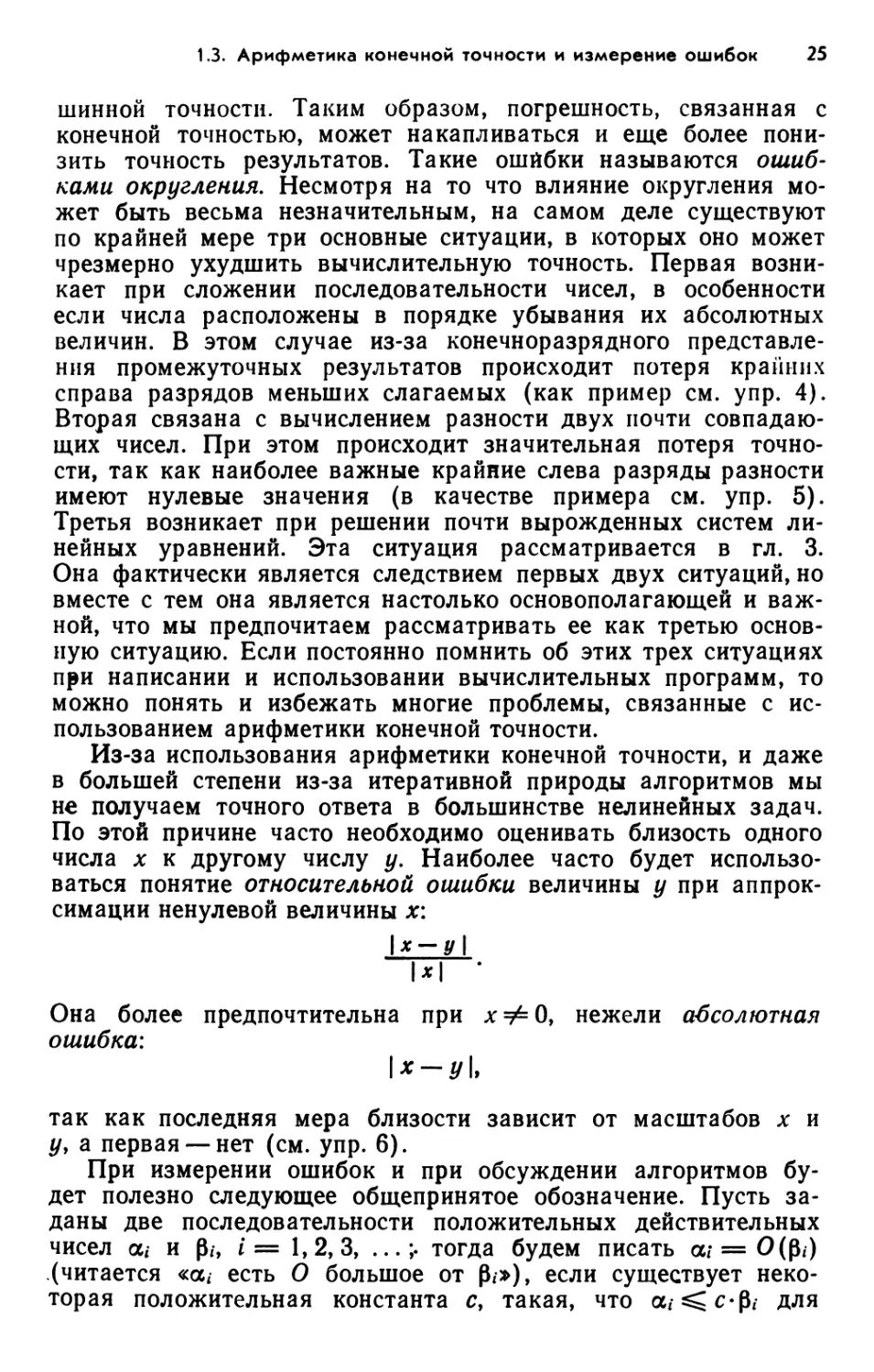

И наконец, соотношение (1.2.2) было всего лишь простой

моделью термоядерного реактора. При более детальном

изучении выяснилось, что функция, определяющая стоимость

единицы электроэнергии, не задается аналитически как в (1.2.2),

а скорее представляет собой выходной результат некоторой

модели реактора, включающей уравнения в частных

производных. К тому же оказалось на пять параметров больше

(рис. 1.2.3). Такого сорта функции встречаются часто в

нелинейной оптимизации, и это серьезно повлияло на развитие

алгоритмов. Прежде всего подобные функции, по-видимому,

имеют лишь несколько верных десятичных знаков, поэтому не

Определенные

значения

параметров

х\.хг хв

с использованием х

как входных данных

модели

Вычисление

/"(численное решение уравнений)

в частных производных! ^ fix х *

с использованием х 1 ' и j. *2,.. ., л»;

Рис. 1.2.3. Вычисление функции по уточненной модели

термоядерного реактора.

22 Гл. 1. Введение

имеет смысла требовать высокой точности в десятичных

знаках решения. Затем хотя функция / может быть много раз

непрерывно дифференцируемой, ее производные обычно

недоступны. Это одна из причин* по которой аппроксимация

производных становится столь актуальной. И наконец,

вычисление / может оказаться довольно дорогостоящим, что служит

дополнительным стимулом к разработке эффективных

алгоритмов.

Приведенные выше задачи дают некоторое представление

о типичных характеристиках нелинейных задач. Первая — это

ее размер. Хотя существуют, конечно, задачи, имеющие

больше переменных, чем в рассмотренных примерах, но большая

часть имеет, на наш взгляд, относительно немного переменных,

скажем от 2 до 30. Современное состояние дел здесь таково,

что можно надеяться решить большинство малых задач,

имеющих, скажем, от 2 до 15 переменных, но при этом даже

двумерные задачи могут оказаться трудными. К задачам среднего

размера в рассматриваемой области относятся те, что имеют

от 15 до 50 переменных. Современные алгоритмы решают

многие из них. Задачи с 50 и более переменными являются

большими. Если о такой задаче нельзя сказать, что она слабо

нелинейна или имеется хорошее начальное приближение к

решению, то у нас мало шансов решить ее эффективно. Эти оценки

размеров очень изменчивы и зависят от алгоритмов меньше,

чем от наличия быстродействующей памяти и других

возможностей ЭВМ.

Второй вопрос касается наличия производных. Часто

встречаются задачи, в которых нелинейная функция сама

определена как результат численного моделирования на ЭВМ или

задается громоздкой формулой. Таким образом, ситуация

часто такова, что в нашем непосредственном распоряжении нет

аналитически заданных производных, хотя сама функция много

раз непрерывно дифференцируема. Поэтому важно иметь

алгоритмы, эффективно работающие в отсутствие аналитических

производных. Действительно, если библиотека программ для

ЭВМ предоставляет возможность аппроксимировать

производные, то пользователи редко задают их аналитически — кто

упрекнет их в этом?

В-третьих, как указывалось выше, решения многих

нелинейных задач довольно дорогостоящи либо из-за

многократного вычисления дорогостоящей нелинейной функции, либо

из-за того, что сама задача заключается в решении большого

числа взаимосвязанных подзадач. Мы слышали о 50-мерной

задаче, связанной с нефтяной техникой, где на каждое

вычисление функции тратится 100 ч работы ЭВМ IBM-3033.

Эффективность, выражаемая в терминах времени счета алгоритма и ко-

1.2. Характерные особенности задач 23

личества вычислений функции и производных, играет важную

роль в развитии нелинейных алгоритмов.

В-четвертых, во многих приложениях пользователь

рассчитывает получить в ответе лишь несколько верных десятичных

знаков. Это вызвано прежде всего тем, что приближенными

по своей природе являются другие составляющие задачи,

например сама функция, параметры модели, данные. С другой

стороны, пользователи часто требуют больше правильных

десятичных знаков, чем им на самом деле нужно. Хотя желание

иметь более высокую точность разумно, скажем, для того,

чтобы удостовериться, что сходимость достигнута, но дело в том,

что необходимая точность редко бывает близка к машинной

точности.

Пятый вопрос, кстати не проиллюстрированный выше,

связан с плохой масштабированностью многих реальных задач.

Имеется в виду, что переменные значительно отличаются

между собой по порядку величины. Например, одна

переменная может постоянно находиться в пределах от 106 до 107, а

другая — в пределах от 1 до 10. В нашей практике такое

встречалось удивительно часто. Однако большинство работ в

данной области обошло вниманием проблему масштабирования.

В книге мы постараемся обратить внимание на случаи, когда

игнорирование эффекта масштабирования может ухудшить

работу нелинейных алгоритмов, и попытаемся исправить эти

недостатки в рассматриваемых алгоритмах.

И наконец, в этой книге рассматриваются только те

нелинейные задачи, где переменные могут принимать любые

действительные значения, в противоположность задачам, где

некоторые переменные принимают только целые значения.

Сказанное относится и ко всем нашим примерам, однако читатель

может поинтересоваться: реалистично ли вообще это

ограничение. Ответ таков, что существуют, конечно, нелинейные

задачи, где некоторые переменные должны быть только

целочисленными, поскольку они представляют собой такие величины,

как, например, число людей, автомобилей и тому подобное.

Однако поскольку утрачивается всякая непрерывность, то эти

ограничения делают задачу настолько сложной для решения,

что часто самым лучшим бывает решить ее, рассматривая

дискретные переменные как непрерывные и затем округляя до

целых числа, полученные в решении. Теоретически такой

подход не гарантирует получение решения исходной

целочисленной задачи, но на практике он часто дает вполне разумное

решение. Исключение составляют задачи, в которых некоторые

дискретные переменные могут принимать только несколько

значений, например 0, 1 или 2. В этом случае должны

использоваться дискретные методы [см., например, Бил (1977), Гар-

финкель и Немхаусер (1972)].

24 Гл. 1. Введение

1.3. АРИФМЕТИКА КОНЕЧНОЙ ТОЧНОСТИ

И ИЗМЕРЕНИЕ ОШИБОК

Некоторые элементы рассматриваемых вычислительных

алгоритмов, такие, как проверка на сходимость, зависят от того,

насколько точно в ЭВМ представляются действительные числа.

Уместно отметить, что понимание машинной арифметики влияет

на написание вычислительных программ. Поэтому нам

необходимо дать краткое описание арифметики, конечной точности,

являющейся машинной версией арифметики действительных

чисел. Более подробно об этом написано в книге Уилкинсона

(1963).

В так называемой экспоненциальной форме записи1) число

51.75 представляется как +0.5175 X Ю+2. В ЭВМ

действительные числа представляются аналогичным образом с

использованием знака (в нашем примере это «+»), основания системы

счисления (10), порядка (+2) и мантиссы (0.5175). Это

представление становится единственным, если потребовать, чтобы

1/основание ^ мантисса < 1,

т. е. первый «десятичный» разряд справа от десятичной точки

не должен быть нулевым. Длина мантиссы, называемая

точностью представления, особенно важна для численных

расчетов. Это представление действительных чисел в ЭВМ

называется представлением с плавающей точкой. Будем обозначать

через fl(jc) представление с плавающей точкой числа *.

На ЭВМ CDC основание равно 2, а мантисса имеет 48

разрядов. Поскольку 2^^ 10м-4, это означает, что можно точно

хранить до 14 значащих десятичных цифр числа. Порядок

может меняться от —976 до +1070, тем самым наименьшее и

наибольшее числа примерно равны 10-294 и 10322. На ЭВМ IBM

основание равно 16, а мантисса состоит из 6 разрядов в

случае одинарной точности и из 14 в случае двойной точности, что

отвечает приблизительно 7 и 16 десятичным разрядам

соответственно. Порядок может меняться от —64 до +63, так что

наименьшее и наибольшее числа примерно равны 10~77 и 1076.

Хранение действительных чисел только с конечной

точностью имеет серьезные последствия, которые можно легко

изложить в краткой форме. Во-первых, коль скоро не всякое

действительное число может быть точно представлено в машине,

то в лучшем случае можно ожидать, что решение будет

верным с машинной точностью. Во-вторых, в зависимости от

машины и компилятора результат каждой промежуточной

арифметической операции либо округляется, либо усекается до ма-

') В оригинале — scientific notation —Прим. перев.

1.3. Арифметика конечной точности и измерение ошибок 25

шинной точности. Таким образом, погрешность, связанная с

конечной точностью, может накапливаться и еще более

понизить точность результатов. Такие ошибки называются

ошибками округления. Несмотря на то что влияние округления

может быть весьма незначительным, на самом деле существуют

по крайней мере три основные ситуации, в которых оно может

чрезмерно ухудшить вычислительную точность. Первая

возникает при сложении последовательности чисел, в особенности

если числа расположены в порядке убывания их абсолютных

величин. В этом случае из-за конечноразрядного

представления промежуточных результатов происходит потеря крайних

справа разрядов меньших слагаемых (как пример см. упр. 4).

Вторая связана с вычислением разности двух почти

совпадающих чисел. При этом происходит значительная потеря

точности, так как наиболее важные крайние слева разряды разности

имеют нулевые значения (в качестве примера см. упр. 5).

Третья возникает при решении почти вырожденных систем

линейных уравнений. Эта ситуация рассматривается в гл. 3.

Она фактически является следствием первых двух ситуаций, но

вместе с тем она является настолько основополагающей и

важной, что мы предпочитаем рассматривать ее как третью

основную ситуацию. Если постоянно помнить об этих трех ситуациях

при написании и использовании вычислительных программ, то

можно понять и избежать многие проблемы, связанные с

использованием арифметики конечной точности.

Из-за использования арифметики конечной точности, и даже

в большей степени из-за итеративной природы алгоритмов мы

не получаем точного ответа в большинстве нелинейных задач.

По этой причине часто необходимо оценивать близость одного

числа х к другому числу у. Наиболее часто будет

использоваться понятие относительной ошибки величины у при

аппроксимации ненулевой величины х:

\х-у\

1*1 '

Она более предпочтительна при хфО, нежели абсолютная

ошибка:

\х — У\>

так как последняя мера близости зависит от масштабов х и

у у а первая —нет (см. упр. 6).

При измерении ошибок и при обсуждении алгоритмов

будет полезно следующее общепринятое обозначение. Пусть

заданы две последовательности положительных действительных

чисел а, и р„ i= 1,2,3, ...;. тогда будем писать а/= 0(0*)

(читается «а,- есть О большое от Pi»), если существует

некоторая положительная константа с, такая, что а/^с-Р/ для

26 Гл. 1. Введение

всех /, за исключением, быть может, конечного подмножества.

Это обозначение используется для указания того, что

величина каждого а, имеет тот же порядок, что и

соответствующее р„ или, возможно, еще меньше. Дополнительные сведения

можно найти в книге Ахо, Хопкрофта и Ульмана (1974).

Другое последствие арифметики конечной точности состоит

в том, что определенные элементы алгоритмов, такие, как

критерий останова, будут зависеть от машинной точности.

Поэтому важно ввести характеристику машинной точности так,

чтобы рассуждения и вычислительные программы могли быть

довольно независимыми от любой конкретной машины. Обычно

используется понятие машинный эпсилон (machine epsilon)

или кратко macheps. Для конкретной вычислительной машины

оно определяется как наименьшее положительное число т,

такое, что 1 + т> 1 (см. упр. 7). Например, поскольку на ЭВМ

CDC имеется 48 двоичных разрядов, то macheps = 2~47 для

арифметики с усечением и 2~48 для арифметики с округлением.

Величина macheps весьма полезна при рассмотрении

машинных чисел. Например, можно легко сказать, что относительная

ошибка машинного представления П(л:) любого

действительного ненулевого числа х меньше, чем macheps, и, наоборот,

машинное представление любого действительного числа х будет

лежать в пределах (x(l — macheps), x(l + macheps)). АнаЛЪ-

гично, два числа хну совпадают в крайней слева половине

их разрядов, когда

'^'^Vmacheps.

Эта проверка довольно типична для наших алгоритмов.

Другой взгляд на величину macheps служит ключом к

трудному вопросу принятия решения о том, когда в определенном

контексте машинное число могло бы также выступать только

как нулевое. Нулем 0 традиционно считается единственное

решение уравнения х + 0 = х для любого действительного

числа х. В случае представления чисел с конечной точностью роль

нуля в этом тождестве играет интервал 0*, который

содержит 0 и приблизительно равняется (—macheps •*, +macheps-A:).

Нередко в процессе вычислений возникают машинные числа

х и у, имеющие настолько различные порядки величин, что

fl(* + y) = fl(x). Это означает, что в данном контексте у

неотличимо от нуля, и иногда, как, например, в численных

алгоритмах линейной алгебры, полезно контролировать вычисления

и, в самом деле, присваивать у нулевое значение.

И наконец, любому пользователю ЭВМ следует знать о

явлениях переполнения и антипереполнения1), встречающихся,

) Это явление называют также исчезновением порядка. — Прим. перев.

1.3. Арифметика конечной точности и измерение ошибок 27

когда в процессе вычислений возникает ненулевое число,

порядок которого больше или соответственно меньше крайних

значений диапазона, отведенного в ЭВМ под порядки. Например,

антипереполнение возникает при обращении на ЭВМ CDC

числа 10322, а переполнение—при обращении на ЭВМ IBM числа

ю-77.

В случае переполнения почти любая вычислительная

машина прекратит счет и выдаст сообщение об ошибке.

Компилятор часто обеспечивает на случай антипереполнения

возможностью выбора — или прекращать счет, или подставлять

нуль вместо выражения, приведшего к этому. Последняя

альтернатива является разумной, но не всегда (см. упр. 8).

К счастью, если использовать хорошо написанные программы

линейной алгебры, то алгоритмы, рассматриваемые в этой

книге, обычно не приводят к переполнению или

антипереполнению. Так, численная реализация вычисления евклидовой

нормы вектора (см. разд. 3.1)

II v I = У*} + *» + ... +v*n, v е R",

требует особой тщательности.

1.4. УПРАЖНЕНИЯ

1. Дайте стандартную формулировку задачи решения системы

нелинейных уравнений: найти (хи х2)т, такое, что

*? + 2 = 4

2. В лабораторном эксперименте измеряются значения функции f в 20

различных моментах времени t в пределах от 0 до 50. Известно, что /(/)

представляет собой синусоидальную волну, однако неизвестны ее амплитуда

и частота, а также ее смещение в направлении осей f и t Как бы вы

поставили вычислительную задачу для нахождения этих характеристик из ваших

экспериментальных данных?

3. У экономиста имеется сложная вычислительная модель экономики,

которая оценивает темпы инфляции по заданным темпам безработицы,

темпам роста валового национального продукта и по числу строившихся в

прошлом году жилых домов. Требуется определить такую комбинацию этих трех

факторов, которая приведет к наименьшим темпам инфляции. Вам предстоит

поставить и решить эту задачу численно.

(a) К какому типу вычислительной задачи ее можно было бы свести?

Как вы поступите с переменной «число строившихся жилых домов»?

(b) В чем состоят те вопросы, которые*вы хотели бы задать

экономисту, стремясь сделать задачу наиболее удобной для численного решения

(например, относительно непрерывности, производных, ограничений)?

(c) Окажется ли решение этой задачи дорогостоящим? Почему?

4. Предположим, в вашем распоряжении имеется вычислительная

машина, у которой основание системы счисления и точность представления чисел

28 Гл. 1. Введение

соответственно равны 10 и 4. Пусть после каждой арифметической

операции производится усечение, так что, например, сумма 24.57 + 128.3 = 152.87

становится равной 152.8. Каковы будут результаты, если сложить числа

128.3, 24.57, 3.163 и "0.4825 сначала в порядке их возрастания, а затем в

порядке убывания? Как они согласуются с правильным «бесконечно точным>

результатом? Что это вам говорит относительно сложения

последовательности чисел на ЭВМ?

5. Предположим у вас имеется та же вычислительная машина, что в

упр. 4, и вы производите вычисление

(1. _ 0.3300 Vo .3300. Сколько верных

цифр по сравнению с точным ответом вы получите? Что это вам говорит

относительно вычитания на ЭВМ почти совпадающих чисел?

6. Каковы относительная и абсолютная ошибки ответа, полученного

ЭВМ в упр. 5, по сравнению с правильным ответом? Что если заменить

задачу на такую: ((-q— ) — 33]/33? Что это вам говорит о полезности

относительной ошибки в сравнении с абсолютной?

7. Напишите программу вычисления машинного эпсилона имеющейся в

нашем распоряжении ЭВМ или микрокалькулятора. Вы можете

предположить, что macheps будет равен' 2 в некоторой степени, так что ваш

алгоритм мог бы выглядеть следующим образом:

EPS := 1

WHILE 1 + EPS > 1 DO

EPS :=* EPS/2.

Введите счетчик, который позволит узнать в конце программы, какой

степенью двойки является macheps. Выведите на печать его значение, а также

десятичную запись числа macheps. (Замечание. Значение macheps будет

отличаться на коэффициент 2 в зависимости от того, какая используется

арифметика — с округлением или с усечением. Почему?)

Дальнейшая информация о вычислении на ЭВМ характеристик

машинного оборудования имеется в статье Форда (1978).

8. В каждом из следующих выражений произойдет антипереполнение

(на ЭВМ IBM). В каких случаях было бы целесообразно подставить нуль

вместо величины, вызывающей антипереполнение?

(a) a:=^/W+cтf где 6—1, с^Ю"50.

(b) а := ^Ь2 + с2, где Ь = с — 10"50.

(c) v := (ю • х)/(у * г), где w =* 10*"30, х = Ю"60, у = 10"40, г = 10"50.

Почему?

2

Нелинейные задачи с одной переменной

Начнем изучение методов решения нелинейных задач с

обсуждения задач, имеющих только одну переменную, таких, как

нахождение решения одного нелинейного уравнения с одним

неизвестным и нахождение минимума функции одной

переменной. Причина для отдельного изучения задач с одной

переменной состоит в том, что они позволяют увидеть те принципы

построения эффективных локальных и глобальных алгоритмов,

а также алгоритмов с аппроксимацией производных, которые

послужат базисом для наших алгоритмов решения задач с

многими переменными. Для этих целей не требуются знания

линейной алгебры и многомерного анализа. Алгоритмы

решения многомерных задач будут более сложными, чем

рассматриваемые в данной главе, однако понимание изложенной здесь

сути основного подхода окажет несомненную помощь в

многомерном случае.

Вот некоторые ссылки на литературу, в которой подробно

рассматриваются задачи этой главы: Авриель (1976), Брент

(1973), Конт и де Бур (1980), Дальквист, Бьёрк и Андерсон

(1974).

2.1. О ТОМ, ЧЕГО НЕ СЛЕДУЕТ ОЖИДАТЬ

Рассмотрим задачу нахождения действительных корней

каждого из следующих трех нелинейных уравнений с одним

неизвестным:

/i М = х4 - 12JC3 + 47Х2 - 60*,

f2 (х) = х4 - 12JC3 + 47Х2 - 60* + 24,

/3 (х) = х4 — 12Ж3 + 47JC2 — 60х + 24.1

(рис. 2.1.1). Было бы замечательно, если бы мы имели

универсальную программу на ЭВМ, которая говорила нам: «Корнями

30 Гл. 2. Нелинейные задачи с одной переменной

f\(x) являются х = 0, 3, 4 и 5; действительными корнями f2(x)

являются х=\ и хё*0.888; fz(x) действительных корней не

имеет».

Вряд ли когда-либо будет существовать такая программа.

Вообще говоря, вопросы существования и единственности,

типа — имеет ли данная задача решение, и единственно ли оно? —

выходят за рамки возможностей, которые следует ожидать от

алгоритмов решения нелинейных задач. В самом деле, мы

должны с готовностью допускать, что для любого

вычислительного алгоритма найдутся нелинейные функции (если желаете,

то даже бесконечно дифференцируемые), достаточно

замысловатые, чтобы вывести из строя этот алгоритм. Поэтому все,

что может гарантировать пользователю алгоритм, примененный

к нелинейной задаче, заключается в ответах: «Приближенным

решением задачи является » или «Приближенное

решение задачи не было найдено за отведенное время». Тем не менее

во многих случаях постановщик нелинейной задачи знает из

практических соображений, что она имеет решение, и либо

решение единственно, либо требуемое решение лежит в

определенной области. Таким образом, невозможность установить

существование или единственность решения обычно не является

тем, что заботит практиков в первую очередь.

Очевидно также, что для большинства нелинейных задач

представляется возможным найти лишь приближенные

решения. Это следует не только из конечной точности наших

вычислительных машин, но также из классического результата

Галуа о том, что для полиномов степени п ^ 5 невозможно

найти решение в замкнутой форме, использующей только

целые числа, операции +, —, X, -f-, возведение в степень и

извлечение корней целой степени от 2-й до n-й. По этой причине

мы будем развивать методы, нацеленные на отыскание одного

из приближенных решений нелинейной задачи.

Рис. 2.1.1. Уравнение fx (х) — х* — \2х9 + 47х2 — 60*.

2.2. Метод Ньютона 31

2.2. МЕТОД НЬЮТОНА РЕШЕНИЯ ОДНОГО

УРАВНЕНИЯ С ОДНИМ НЕИЗВЕСТНЫМ

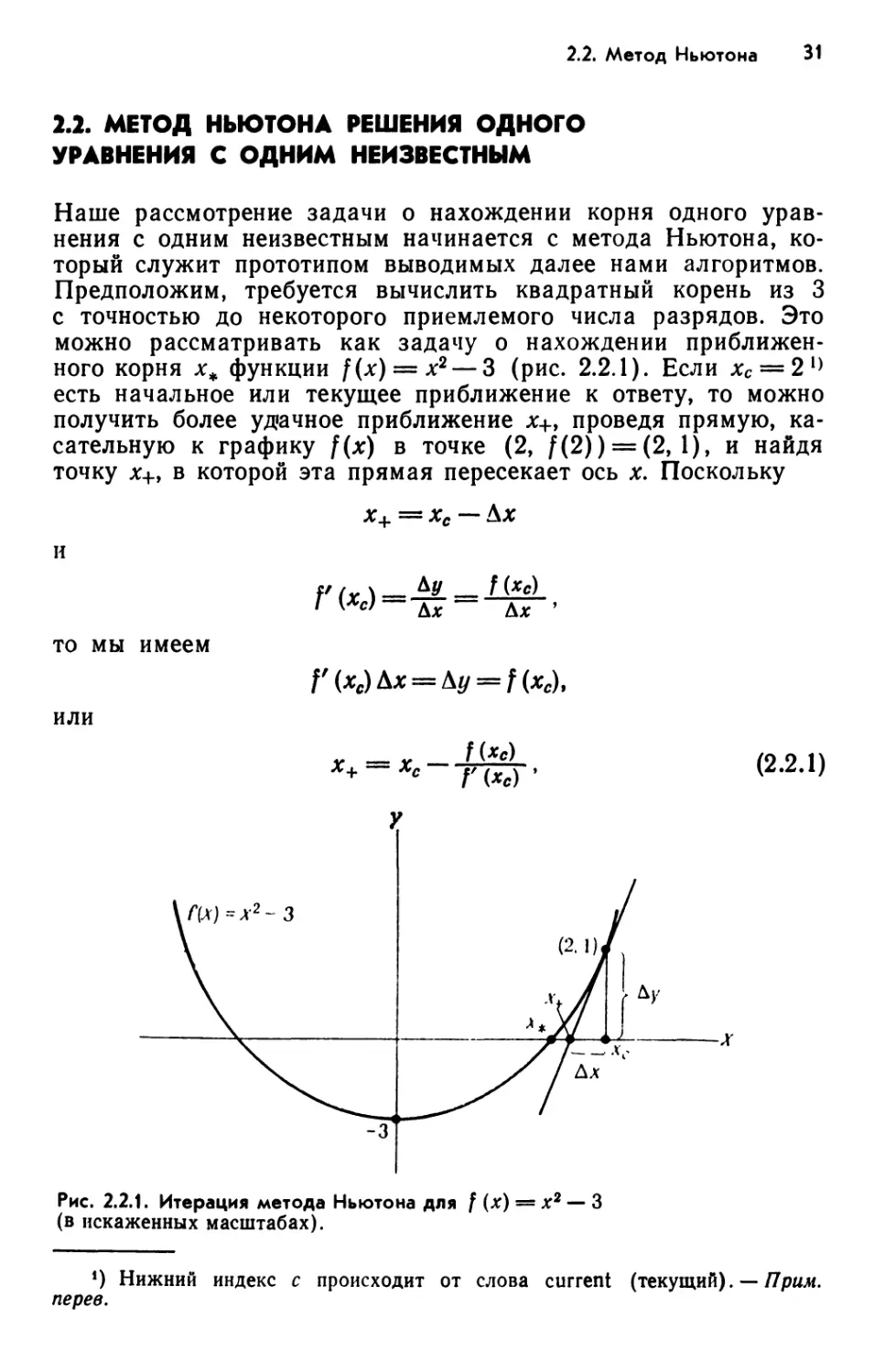

Наше рассмотрение задачи о нахождении корня одного

уравнения с одним неизвестным начинается с метода Ньютона,

который служит прототипом выводимых далее нами алгоритмов.

Предположим, требуется вычислить квадратный корень из 3

с точностью до некоторого приемлемого числа разрядов. Это

можно рассматривать как задачу о нахождении

приближенного корня х* функции f(x) = x2 — 3 (рис. 2.2.1). Если хс = 21)

есть начальное или текущее приближение к ответу, то можно

получить более удачное приближение *+, проведя прямую,

касательную к графику f(x) в точке (2, f(2)) = (2, 1), и найдя

точку х+, в которой эта прямая пересекает ось х. Поскольку

х+ = хс — Ал:

ftr\ — *У — f(*c)

Г К*с) — Дл: — Дл. >

то мы имеем

или

П*с) Л* = Л</= /(**),

Х+ — Хс Г <*«>

(2.2.1)

Рис. 2.2.1. Итерация метода Ньютона для / (х) = х2 — 3

(в искаженных масштабах).

!) Нижний индекс с происходит от слова current (текущий). — Прим.

пере в.

32 Гл. 2. Нелинейные задачи с одной переменной

что дает

1

X

+ = 2-f = ;i.75.

Логично следующим шагом применить тот же прием к но-

ному текущему приближению хс = 1.75. Использование (2.2.1)

дает

х+ = 1.75 - (0.0625/3.5) = 1.732у,

которое уже имеет четыре верных разряда числа д/3. Еще

одна итерация дает х+^ 1.7320508, которое имеет восемь

верных разрядов.

Метод, который мы только что вывели, называется методом

Ньютона — Рафсона, или методом Ньютона. Для лучшего

понимания было бы важно взглянуть на то, что нами сделано,

с более абстрактных позиций. На каждой итерации строилась

локальная модель функции f(x) и решалась задача отыскания

корня этой модели. В данном случае наша модель

Мс (х) = f (хс) + Г (хс) (х - хс) (2.2.2)

представляет собой единственную линейную функцию со

значением f(xc) и наклоном f'{xc) в точке хс (прописная буква М

используется здесь в соответствии с обозначениями в

многомерном случае и во избежание путаницы с задачами

минимизации, где наша модель обозначается через тс(х)). Нетрудно

убедиться в том, что Мс(х) пересекает ось х в точке *+,

определенной в (2.2.1).

Из педагогических соображений надо сказать, что мы по«

лучили метод Ньютона, представляя f{x) в окрестности

текущего приближения Хс в виде ее ряда Тейлора:

f(x) = f(xe) + f'(xe)(x-xe)+ ГМ(х-х.у + _

21

-Z

ГЧхе)(х-хе)< (223)

/-0

и затем аппроксимируя f(x) аффинной1) частью этого ряда,

которая тоже, естественно, задается формулой (2.2.2). Корень

опять же задается формулой (2.2.1). Имеется несколько

причин, по которым мы предпочитаем другой подход. Малопри-

') Будем называть (2.2.2) аффинной моделью, несмотря на то что ее

часто называют линейной моделью. Причина заключается в том, что

аффинная модель соответствует афинному подпространству, проходящему через

(х, f(x))t т.е. соответствует прямой, которая не обязательно проходит через

начало координат, тогда как линейное подпространство обязательно

проходит через начало координат.

2.2. Метод Ньютона 33

влекательно, да и вовсе нет необходимости в том, чтобы

строить предположения относительно производных порядка более

высокого, чем на самом деле используется на итерации. Кроме

того, при рассмотрении многомерных задач производные более

высокого порядка становятся настолько сложными, что их

понимание требует больших усилий, чем любой из приводимых

далее алгоритмов.

Вместо этого метод Ньютона получается просто и

естественно из теоремы Ньютона 1)

X

f(x) = f(xe)+ \f'(z)dz.

хс

Представляется разумным аппроксимировать этот интеграл по

формуле

х

\f'(z)dz~f'(xc)(x-xc)

хс

и еще раз получить аффинную аппроксимацию f{x)9 заданную

в (2.2.2). Такой способ вывода окажется для нас полезным

в многомерных задачах, где различные способы вывода из

геометрических соображений становятся менее успешными.

Метод Ньютона типичен для методов решения нелинейных

задач. Он является итерационным процессом, генерирующим

последовательность точек, которые, как мы надеемся,

становятся все более близкими к решению. Возникает естественный

вопрос: «Будет ли он работать?» Ответом является твердое

«да». Отметим, что если бы f(x) была линейной, то метод

Ньютона нашел бы ее корень за одну итерацию. Теперь

посмотрим, что он будет делать в общей задаче нахождения

квадратного корня:

задано <х>0, найти х, такое, что f(x) = x? — а = 0,

начиная с текущего приближения хсФО. Поскольку

— f(*c) _ *с-а _ ХС i °

*+ — Хс у {Хс) —Хс 2хс — 2 + 2хс ,

имеем

или, используя относительную погрешность, получаем

х, — л/а ( * — л/а \2 / л/а \

^т- - (-V-) • (У • <2-2-4Ь>

*) В отечественной литературе эта теорема известна как формула

Ньютона—Лейбница. При переволе будем придерживаться терминологии

оригинала. — Прим. перев.

34 Гл. 2. Нелинейные задачи с одной переменной

Таким образом, коль скоро начальная погрешность \хс — д/а |

меньше, чем \2хс\, то новая погрешность |л;+ — У<х | будет

меньше старой погрешности |*с — Va I» и в конце концов

каждая новая погрешность будет гораздо меньше предыдущей

погрешности. Это согласуется с нашими наблюдениями при

нахождении квадратного корня из 3 в примере, с которого

начинался данный раздел.

Характер уменьшения погрешности, заданной (2.2.4),

типичен для метода Ньютона. Погрешность на каждой итерации

будет приблизительно равна квадрату предыдущей

погрешности, так что если начальное приближение было достаточно

хорошим, то погрешность будет уменьшаться и в конце концов

уменьшение станет быстрым. Такой характер сходимости

известен как локальная ^-квадратичная сходимость. Прежде чем

получить общую теорему сходимости метода Ньютона,

необходимо обсудить вопрос о скорости сходимости.

2.3. СХОДИМОСТЬ ПОСЛЕДОВАТЕЛЬНОСТЕЙ

ДЕЙСТВИТЕЛЬНЫХ ЧИСЕЛ

Пусть задан итерационный метод, генерирующий

последовательность точек хих2у ... из начального приближения х0. Нам

бы хотелось знать — сходятся ли итерации к решению х„ и

если сходятся, то как быстро. Предположим, что нам известно

то, что подразумевается под записью

lim ak = О

fc-»oo

для последовательности действительных чисел {а*}. Тогда

следующее определение дает необходимые нам в дальнейшем

характеристики свойств сходимости.

Определение 2.3.1. Пусть jc+eK, xk^R, £ = 0,1,2, ... .

Тогда говорят, что последовательность {**} = {дсо, х\,х2, ...}

сходится к х„ если

lim |xk — х0\ = 0.

fc->oo

Если, кроме того, существуют константа се [0, 1) и целое k ^ 0,

такие, что для всех k ^ &

l*A+i —*. К *1 ** — *.!■

то говорят, что {xk} является q-линейно сходящейся к х*. Если

для некоторой последовательности {ck}> сходящейся к 0, имеет

место

1*м-хт\<ск\хк — хл |, (2.3.2)

2.3. Сходимость последовательностей действительных чисел 35

то говорят, что {xk} сходится q-сверхлинейно к х*. Если {xk}

сходится к х* и существуют постоянные р>1, с>0 и й^О,

такие, что для всех k ^ #

\хк+1-х.\^с\хк-хш\р, (2.3.3)

то говорят, что {xk} сходится к4 с q-порядкоМу по меньшей

мере равным р. Если р = 2 или 3, то говорят, что скорость

сходимости является q-квадратичной или q-кубической

соответственно.

Если {л:*} сходится к х* и вместо (2.3.2) выполняется

\xk+J — xj^ck\xk — xj

для некоторого фиксированного целого /, то говорят, что {л:*}

является j-шагово q-сверхлинейно сходящейся к х*. Если {л:*}

сходится к Xk н вместо (2.3.3) для k ^ £ выполняется

I **+/ — *. К *|*Л — xj

при некотором фиксированном целом /, то говорят, что {xk}

имеет j-шаговую сходимость q-порядка, по меньшей мере

равного р.

Примером q-линешой сходимости служит

последовательность

Xq = 2, Х\ = Tj- , Х2 = -£-, *з = "g"» • • • > AT/ = 1 + 2 , ....

Эта последовательность сходится к jt*=l, имея с = у. Нг

ЭВМ CDC потребуется 48 итераций для достижения fl(**) = l.

Примером <7-кваДРатично сходящейся последовательности

служит

y — 1 — 5 — 17 _ 257 _ 1 i о-2*

0 — 2 ' Х{ — 4 ' *2 — ~\6 ' Хз — 256 »•••>** — А i ^ > • • • >

которая сходится к jq* = 1, имея с= 1. На ЭВМ CDC f 1 (дг6)

будет равно 1. На практике ^-линейная сходимость может

быть довольно медленной, в то время как ^-квадратичная или

<7-сверхлинейная сходимость станет в конце концов довольно

быстрой. Однако реальное поведение также зависит от

констант с в (2.3.1—2.3.3), например q-липешая сходимость

с с = 0.001, вероятно, является вполне удовлетворительной, а

с с = 0.9 — нет. (Другие примеры имеются в упр. 2 и 3.) Стоит

подчеркнуть, что эффективность 9_свеРхлинейной сходимости

непосредственно связана с тем, сколько итераций требуется

для того, чтобы ck стало малым.

Когда речь идет о порядках сходимости, следует различать

префикс «9», происходящий от слова quotient (частное), и «г»,

происходящий от root (корень), г-порядок характеризует

скорость сходимости более слабого типа. В этом случае все, что

36 Гл. 2. Нелинейные задачи с одной переменной

можно сказать про погрешности \xk — х*\ последовательности,

имеющей г-порядок, равный р, заключается в том, что они

ограничены сверху другой последовательностью с <7-поРяДком>

равным р. Строгое определение имеется в книге Ортеги и

Рейнболдта (1970). Итеративный метод, сходящийся с

определенной скоростью к истинному решению при условии, что он

стартует в достаточной близости от этого решения, называется

локально сходящимся с упомянутой скоростью. В этой книге

нас будут интересовать главным образом методы, которые

сходятся локально 9-сверхлинейно или ^-квадратично и у которых

такое поведение явно наблюдается на практике.

2.4. СХОДИМОСТЬ МЕТОДА НЬЮТОНА

Здесь будет показано, что для большинства задач метод

Ньютона сходится ^-квадратично к корню одного нелинейного

уравнения с одним неизвестным при условии, что имеется

достаточно хорошее начальное приближение. Однако он может

вообще не сходиться из-за плохого начального приближения, и

тогда необходимо привлекать глобальные методы из разд. 2.5.

Доказательство локальной сходимости метода Ньютона

опирается на оценку погрешностей в последовательности

аффинных моделей Мс(х), рассматриваемых как аппроксимации для

f(x). Поскольку эта аппроксимация была получена с

использованием f'(xc) (х — хс) в качестве аппроксимации для

х

\f'{z)dz,

хс

то нам необходимо сделать некоторые предположения

относительно гладкости р с тем, чтобы оценить погрешность

аппроксимации, равную

х

f{x)-Mc{x)= $ [/'(*)-П*с)]Жг.

хс

Прежде всего дадим определение непрерывности по Липшицу.

Определение 2.4.1. Функция g называется непрерывной по

Липшицу с константой у на множестве X (записывается как

g<=Lipy(X))t если

\g(*) — g(y)\<y\x — y\

для любых х,у^Х.

Для установления сходимости метода Ньютона докажем

сначала простую лемму, показывающую, что если Р(х) непре-

2.4. Сходимость метода Ньютона 37

рывна по Липшицу, то можно получить верхнюю границу

близости аппроксимации f(x)-\-f'(x) (у — х) к f(y).

Лемма 2.4.2. Пусть /: D-+R и //eLipY(D) для открытого

интервала D. Тогда для любых x,y^D

lf(y)-f(*)-n*)(*/-*)l<Y(y2-*)2- (2.4.1)

Доказательство. Как известно из основ анализа, f(y) — f(x) =

у

= \ Y fe) dz, что эквивалентно

х

У

f(y)-f (х) - Г (х) (У~х) = \ W (г) - Y (*)] dz. (2.4.2)

X

После замены переменных

z = x + t(y — x), dz = dt(y — x)

(2.4.2) принимает вид

f(y)-f(x)-f'(x)(y-x)=\[f'(x + t(y-x))-f'(x)](y-x)dt.

о

И, таким образом, используя непрерывность по Липшицу /',

получаем

1Ш-/М-П*)(»-*)К

<\У- x\\y\t(y-x)\dt = y\y-xfl2. П

о

Отметим, что (2.4.1) очень напоминает оценку погрешности,

определяемой остаточным членом в формуле Тейлора, при этом

константа Липшица у играет роль ограничения сверху на

If (5)1» где £eZ). Основное преимущество использования

непрерывности по Липшицу заключается в том, что оно

освобождает нас от необходимости рассматривать следующую по

порядку производную. Это особенно удобно в многомерном

случае.

Теперь мы в состоянии сформулировать и доказать

фундаментальную теорему вычислительной математики. Будет

доказана самая полезная форма этого результата, а более общие

вынесены в упражнения (см. упр. 13—14).

Теорема 2.4.3. Пусть /: D->R, где D — открытый

интервал Д и пусть f eLi/?Y(D). Предположим, что для некоторого

38 Гл. 2. Нелинейные задачи с одной переменной

р > 0 |f(*)I^P ПРИ всех x^D. Если f(x) = 0 имеет решение

**еО, то существует некоторое ц > О, такое, что если |х0 —

— **|<Л> то последовательность {**}, задаваемая формулой

Xk+i = xk— у . . , & = 0, 1, 2, ...,

существует и сходится к х*. Более того, для £ = 0,1, ...

Доказательство. Пусть те(0,1), и пусть т) есть радиус1)

наибольшего открытого интервала с центром в х*,

содержащегося в D. Обозначим rj = min{fj, т(2р/у)}. Покажем по

индукции, что для k = 0, 1, 2, ... выполняется (2.4.3) и

Доказательство по сути просто показывает, что на каждой

итерации погрешность \xk+\ — **| ограничена константой,

умноженной на погрешность, допускаемую аффинной моделью

при аппроксимации / в л% и оцениваемую по лемме 2.4.2 как

О(|агл — х*\2). Для k = 0

X\ x. — Xo *. -jr—--x0 x4 ^,(jCq) —

= 77^-5- [/ (x.) - f (x0) - Г (x0) (x. - *o)].

Выражение в скобках есть f(x+)—M0(xl), т. е. погрешность

в лс* локальной аффинной модели, построенной в хс=х0.

Таким образом, из леммы 2.4.2

1 *1 ~~ х*' ^ 2|f'(*o)l ,Ar°"~ **|2>

и далее по предположениям относительно f'(x)

\x{-xj^-^\x0 — xj2.

Поскольку |л'0 — *«|^Л ^ т -2p/v, мы имеем |*i—л*|^

^т|х0 — хф|<т|. Аналогично проводится доказательство

индуктивного предположения. П

Требование теоремы 2.4.3 о том, чтобы f'(x) имело

ненулевую нижнюю границу в Z), просто означает, что /'(#*) должно

*) Такого рода терминология, присущая скорее многомерному случаю,

чем одномерному, не вызывает серьезных трудностей и используется для

облегчения дальнейшего перехода к случаю пространства многих

переменных. — Прим. перев.

2.4. Сходимость метода Ньютона 39

быть ненулевым для квадратичной сходимости метода

Ньютона. Если на самом деле /'(**)= О, то х* является кратным

корнем, и метод Ньютона сходится всего лишь линейно (см.

упр. 12). Для того чтобы ощутить разницу, мы приводим ниже

пример итераций метода Ньютона, примененного к f{(x) =

= х2—1 и к Ы*) = *2 — 2х+1, начиная в обоих случаях

с лго = 2. Обратите внимание, что метод Ньютона в случае

f2(x) сходится гораздо медленнее из-за f'2(xj = 0.

Пример 2.4.4. Метод Ньютона, примененный к двум

квадратичным функциям (ЭВМ CDC, одинарная точность).

М*) = *2-1 f2(x) = x2-2x + \

2.0

1.25

1.025

1.0003048780488

1.0000000464611

1.0

*о

xt

%2

х3

х4

*5

2.0

1.5

1.25

1.125

1.0625

1.03125

Поучительно также рассмотреть константу у/(2р),

входящую в соотношение для ^-квадратичной скорости сходимости

(2.4.3). Числитель у> представляющий собой константу

Липшица для /' на Z), можно рассматривать как меру

нелинейности f. Однако мера у зависит от масштаба: умножение / или

изменение единиц измерения х на некоторую константу

изменит масштаб /' на эту константу, не делая функцию ни более

и ни менее нелинейной. Мерой нелинейности, не зависящей от

масштаба1), служит относительная скорость изменения /'(*),

которая получается делением у на f'(x). Таким образом,

поскольку р есть нижняя граница для f'(x) при jcgD, то у/р

является верхней границей относительной нелинейности f(x),

и теорема 2.4.3 утверждает, что чем меньше эта мера

относительной нелинейности, тем быстрее будет сходиться метод

Ньютона. Если же / линейна, то у = 0 и х\ = х*.

Теорема 2.4.3 гарантирует сходимость метода Ньютона

только из хорошей начальной точки хо, и, в самом деле, как

легко убедиться, метод Ньютона может вообще не сходиться,

если |л0 — л^| велико. Рассмотрим, например, функцию f(x) =

= arctg* (рис. 2.4.1). Для некоторого jtce [1,39, 1.40]

справедливо следующее. Если х0 = хс, то метод Ньютона будет

генерировать циклически повторяющиеся значения a'i = —л>,

Х2 = хСу хг = —хс, .... Если |лго|<л'с, то метод Ньютона

будет сходиться к л-* = 0, а если |jc0|>xo то метод Ньютона

!) Имеется в гиду лишь независимость от единиц измерения f, а не х.—

Прим. пере в.

40 Гл. 2. Нелинейные задачи с одной переменной

•f(*;«=3rctg х

X

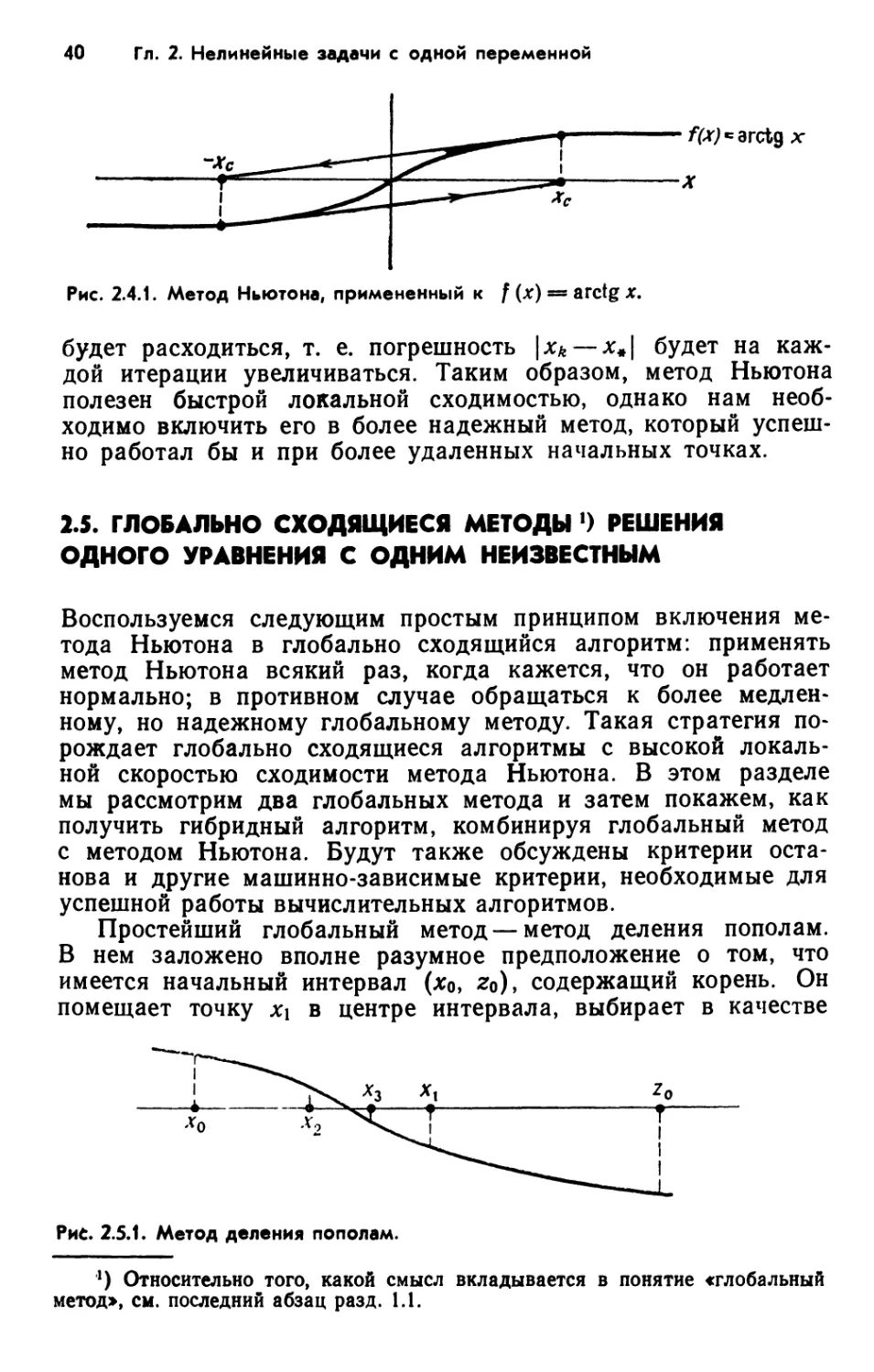

Рис. 2.4.1. Метод Ньютона, примененный к / (х) = arctg х.

будет расходиться, т. е. погрешность \хк — а:«| будет на

каждой итерации увеличиваться. Таким образом, метод Ньютона

полезен быстрой локальной сходимостью, однако нам

необходимо включить его в более надежный метод, который

успешно работал бы и при более удаленных начальных точках.

2.5. ГЛОБАЛЬНО СХОДЯЩИЕСЯ МЕТОДЫ 0 РЕШЕНИЯ

ОДНОГО УРАВНЕНИЯ С ОДНИМ НЕИЗВЕСТНЫМ

Воспользуемся следующим простым принципом включения

метода Ньютона в глобально сходящийся алгоритм: применять

метод Ньютона всякий раз, когда кажется, что он работает

нормально; в противном случае обращаться к более

медленному, но надежному глобальному методу. Такая стратегия

порождает глобально сходящиеся алгоритмы с высокой

локальной скоростью сходимости метода Ньютона. В этом разделе

мы рассмотрим два глобальных метода и затем покажем, как

получить гибридный алгоритм, комбинируя глобальный метод

с методом Ньютона. Будут также обсуждены критерии

останова и другие машинно-зависимые критерии, необходимые для

успешной работы вычислительных алгоритмов.

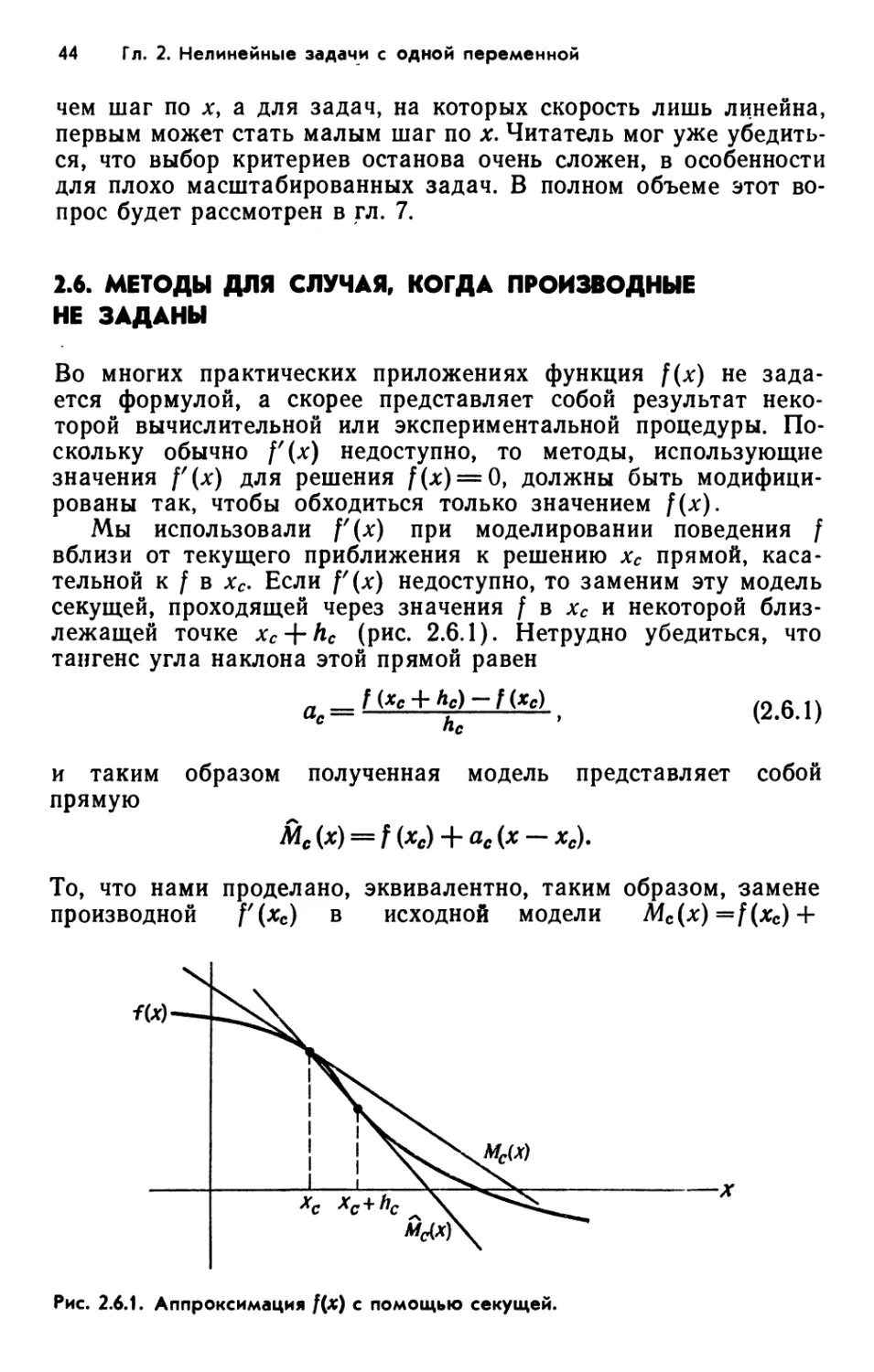

Простейший глобальный метод—метод деления пополам.

В нем заложено вполне разумное предположение о том, что

имеется начальный интервал (x0t z0), содержащий корень. Он

помещает точку х\ в центре интервала, выбирает в качестве

Рис. 2.5.1. Метод деления пополам.

1) Относительно того, какой смысл вкладывается в понятие «глобальный

метод», см. последний абзац разд. 1.1.

2.5. Глобально сходящиеся методы 41

нового тот из интервалов [*о,Х\] и [jti,Zo]> который содержит

корень, и продолжает делить отрезок пополам до тех пор, пока

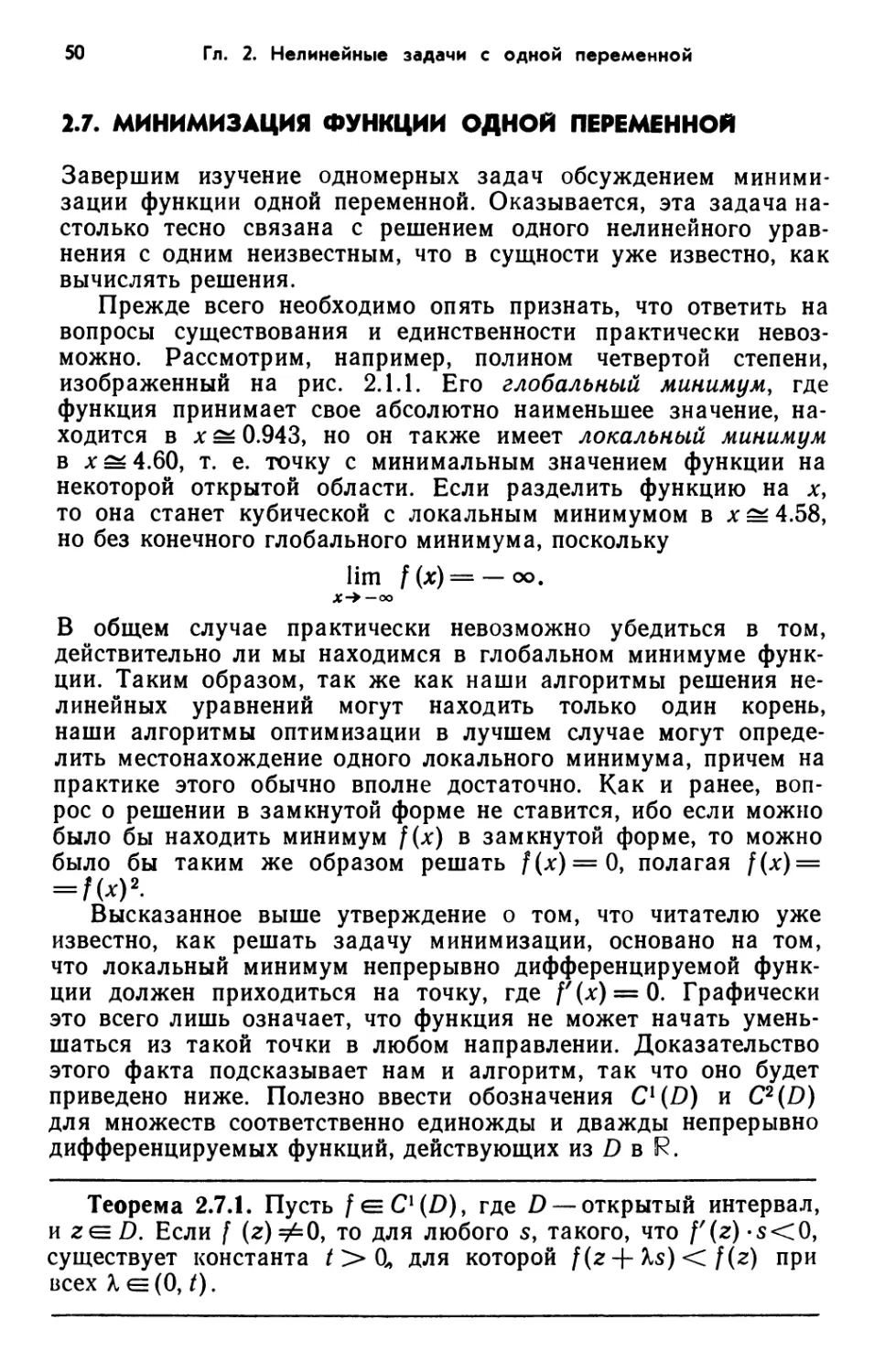

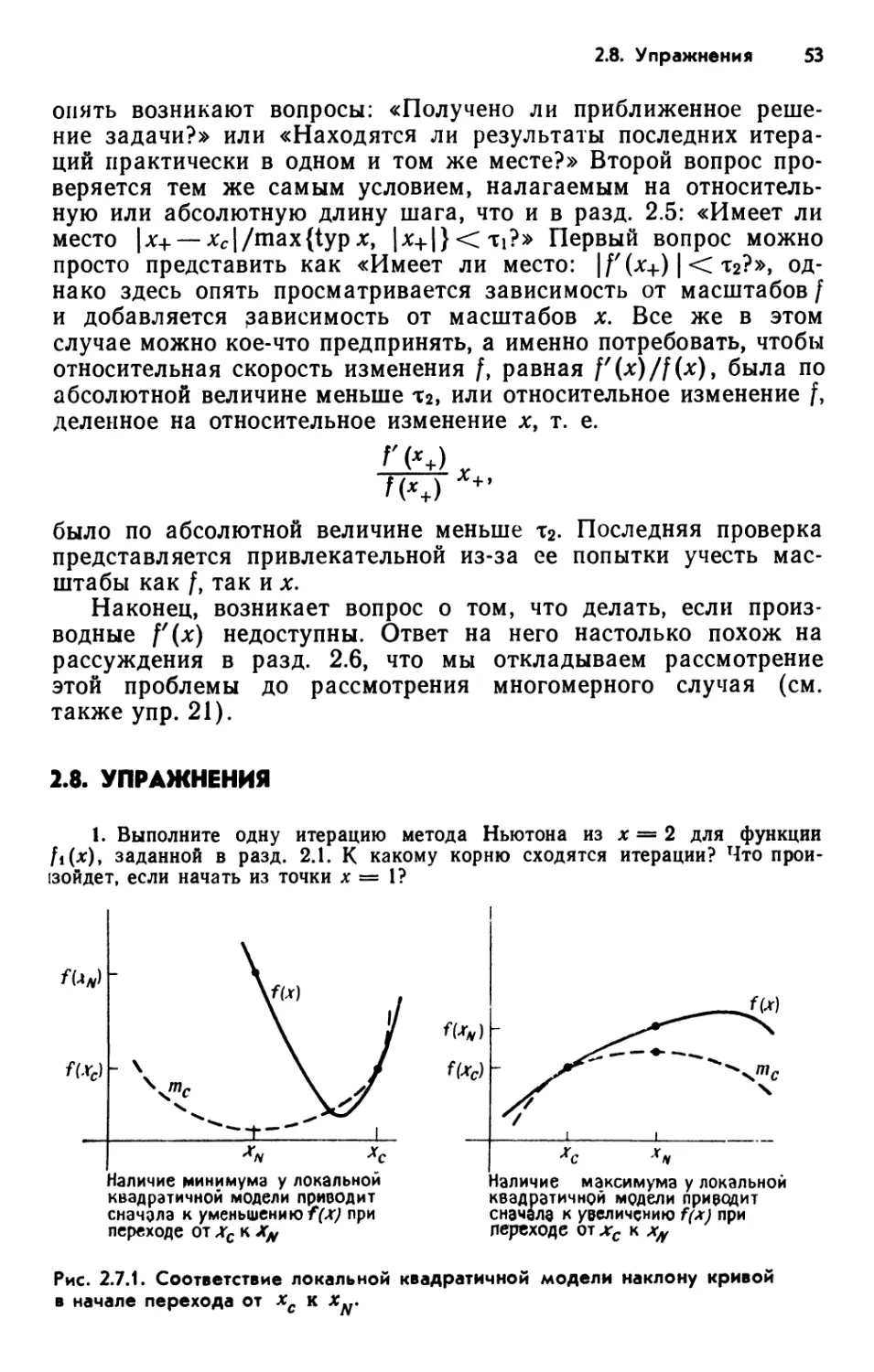

не будет найден корень (рис. 2.5.1). Формально это выглядит