Автор: Медик В.А. Токмачев М.С. Фишман Б.Б.

Теги: медицинские науки биологические науки в целом общественные науки социальная гигиена и организация здравоохранения в прежнем ссср (снг) медицина статистика биология

ISBN: 5-225-04630-4

Год: 2000

*■ -; - -J.

*fcfc

^■2^-'-*-*:с*^?:^ :^,^пшй£<

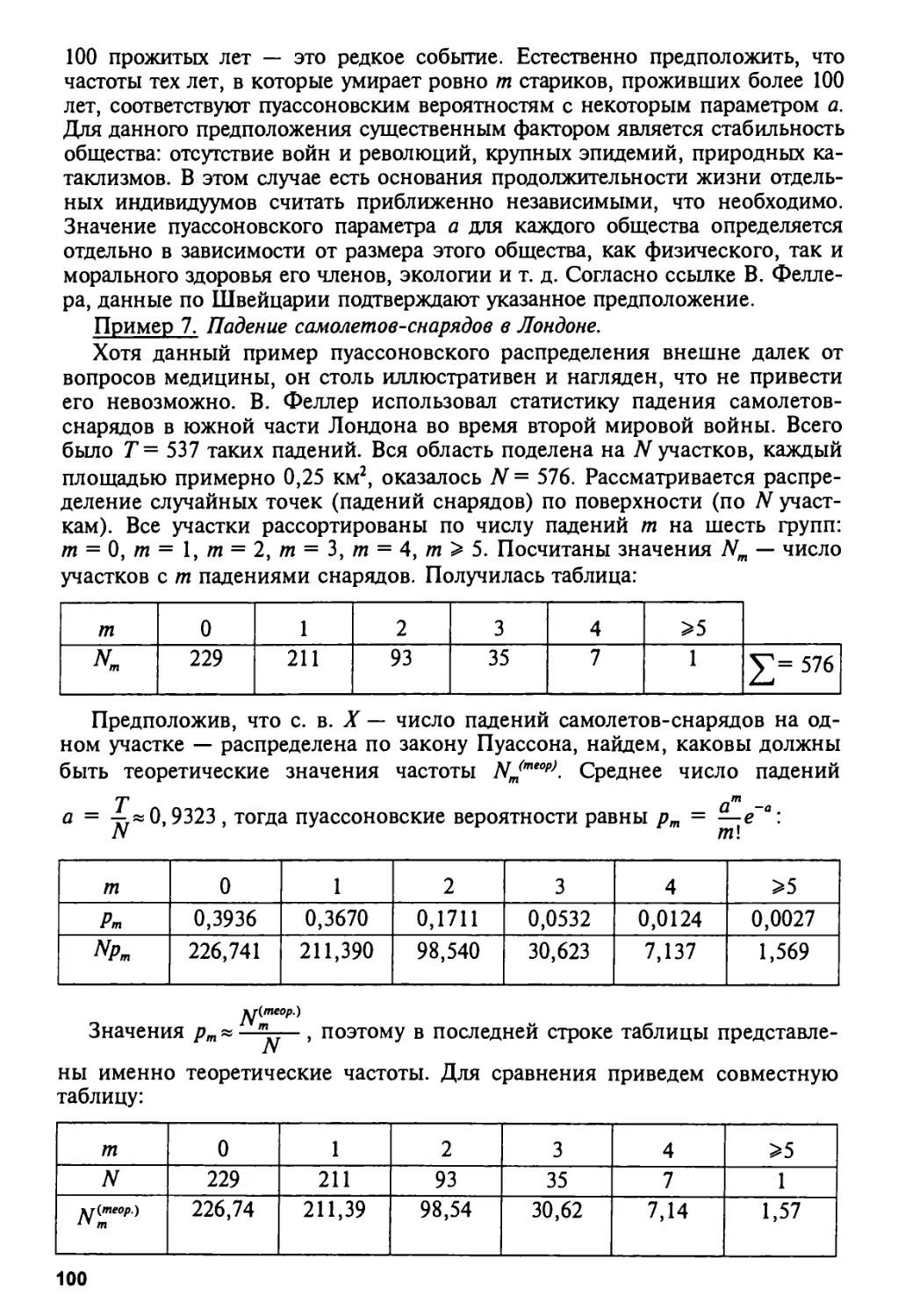

^■'v=c

3*

Л«-;>;^1

■*■ *

^УЗ&л.рд 'Т

: ♦

ч тошя

■--#*

;^ та 'ст i

Северо-Западное отделение Российской академии медицинских наук

Новгородский научный Центр

Новгородский государственный университет имени Ярослава Мудрого

В. А. Медик, М. С. Токмачев, Б. Б. Фишман

СТАТИСТИКА

В МЕДИЦИНЕ И БИОЛОГИИ

Руководство в 2-х томах под редакцией профессора Ю. М. Комарова

том

1

Теоретическая статистика

э

Москва

«МЕДИЦИНА»

2000

УДК61+57]:31

ББК 51.1(2)

М42

РЕЦЕНЗЕНТЫ: член-корреспондент РАМН, доктор

медицинских наук, профессор В. 3. Кучеренко, доктор

медицинских наук, профессор В. Г. Кудрина.

Медик В. А., Токмачев М. С, Фишман Б. Б.

М42 Статистика в медицине и биологии: Руководство. В 2-х

томах / Под ред. Ю. М. Комарова. Т. 1. Теоретическая

статистика. — М.: Медицина, 2000. — 412 с. ISBN 5-225-

04630-4

В первом томе представлены основные понятия и методы

математической статистики, изложен курс основ теории вероятностей, где

рассмотрены случайные события, случайные величины и системы случайных

величин. Приведены материалы по анализу данных, статистические

критерии, исследование зависимости групп наблюдений, причем

использованы как параметрические, так и непараметрические современные методы.

Представлены многочисленные примеры, иллюстрирующие прикладную

направленность статистики.

Руководство предназначено для студентов медицинских и

биологических специальностей, медицинских работников и организаторов

здравоохранения, а также ученых и исследователей — специалистов НИИ

медицинского и биологического профилей.

Рассмотрено, одобрено и рекомендовано секцией по социальной

гигиене и организации здравоохранения Ученого Совета МЗ РФ

ББК 51.1(2)

ISBN 5-225-04630-4 © В. А. Медик, М. С. Токмачев,

Б. Б. Фишман, 2000

Все права автора защищены. Ни одна часть этого издания не может быть

занесена в память компьютера либо воспроизведена любым способом без

предварительного письменного разрешения издателя.

Авторский коллектив

МЕДИК Валерий Алексеевич, член-корреспондент РАМН, доктор

медицинских наук, профессор, директор Новгородского научного Центра СЗО

РАМН, заведующий кафедрой социальной медицины, экономики и

управления здравоохранением института медицинского образования

Новгородского государственного университета имени Ярослава Мудрого.

ТОКМАЧЕВ Михаил Степанович, кандидат физико-математических наук,

доцент кафедры прикладной математики Новгородского государственного

университета имени Ярослава Мудрого.

ФИШМАН Борис Борисович, доктор медицинских наук, профессор

кафедры социальной медицины, экономики и управления здравоохранением

института медицинского образования Новгородского государственного

университета имени Ярослава Мудрого.

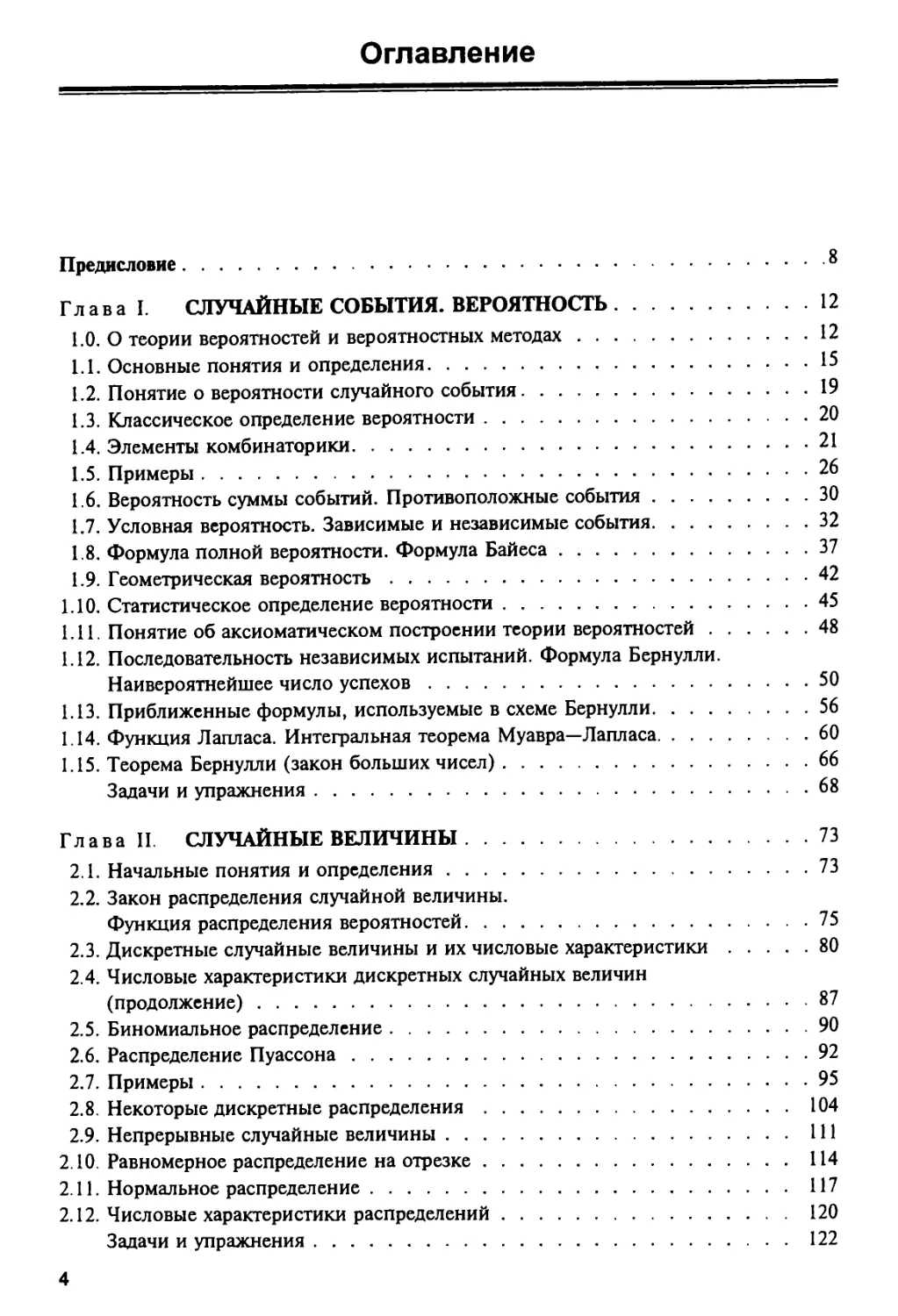

Оглавление

Предисловие 8

Глава I. СЛУЧАЙНЫЕ СОБЫТИЯ. ВЕРОЯТНОСТЬ 12

1.0. О теории вероятностей и вероятностных методах 12

1.1. Основные понятия и определения 15

1.2. Понятие о вероятности случайного события 19

1.3. Классическое определение вероятности 20

1.4. Элементы комбинаторики 21

1.5. Примеры 26

1.6. Вероятность суммы событий. Противоположные события 30

1.7. Условная вероятность. Зависимые и независимые события 32

1.8. Формула полной вероятности. Формула Байеса 37

1.9. Геометрическая вероятность 42

1.10. Статистическое определение вероятности 45

1.11. Понятие об аксиоматическом построении теории вероятностей 48

1.12. Последовательность независимых испытаний. Формула Бернулли.

Наивероятнейшее число успехов 50

1.13. Приближенные формулы, используемые в схеме Бернулли 56

1.14. Функция Лапласа. Интегральная теорема Муавра—Лапласа 60

1.15. Теорема Бернулли (закон больших чисел) 66

Задачи и упражнения 68

Глава II СЛУЧАЙНЫЕ ВЕЛИЧИНЫ 73

2.1. Начальные понятия и определения 73

2.2. Закон распределения случайной величины.

Функция распределения вероятностей 75

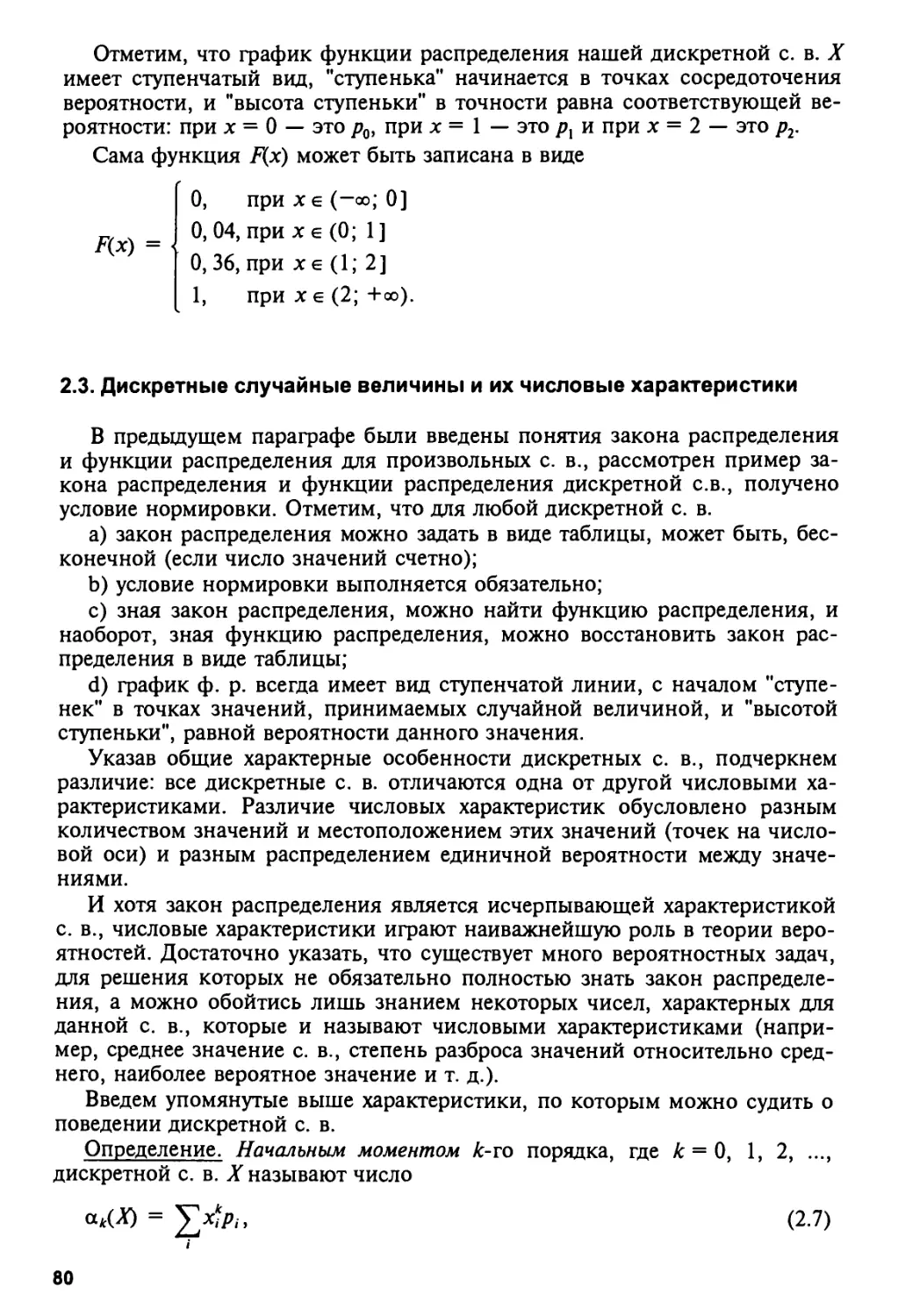

2.3. Дискретные случайные величины и их числовые характеристики 80

2.4. Числовые характеристики дискретных случайных величин

(продолжение) 87

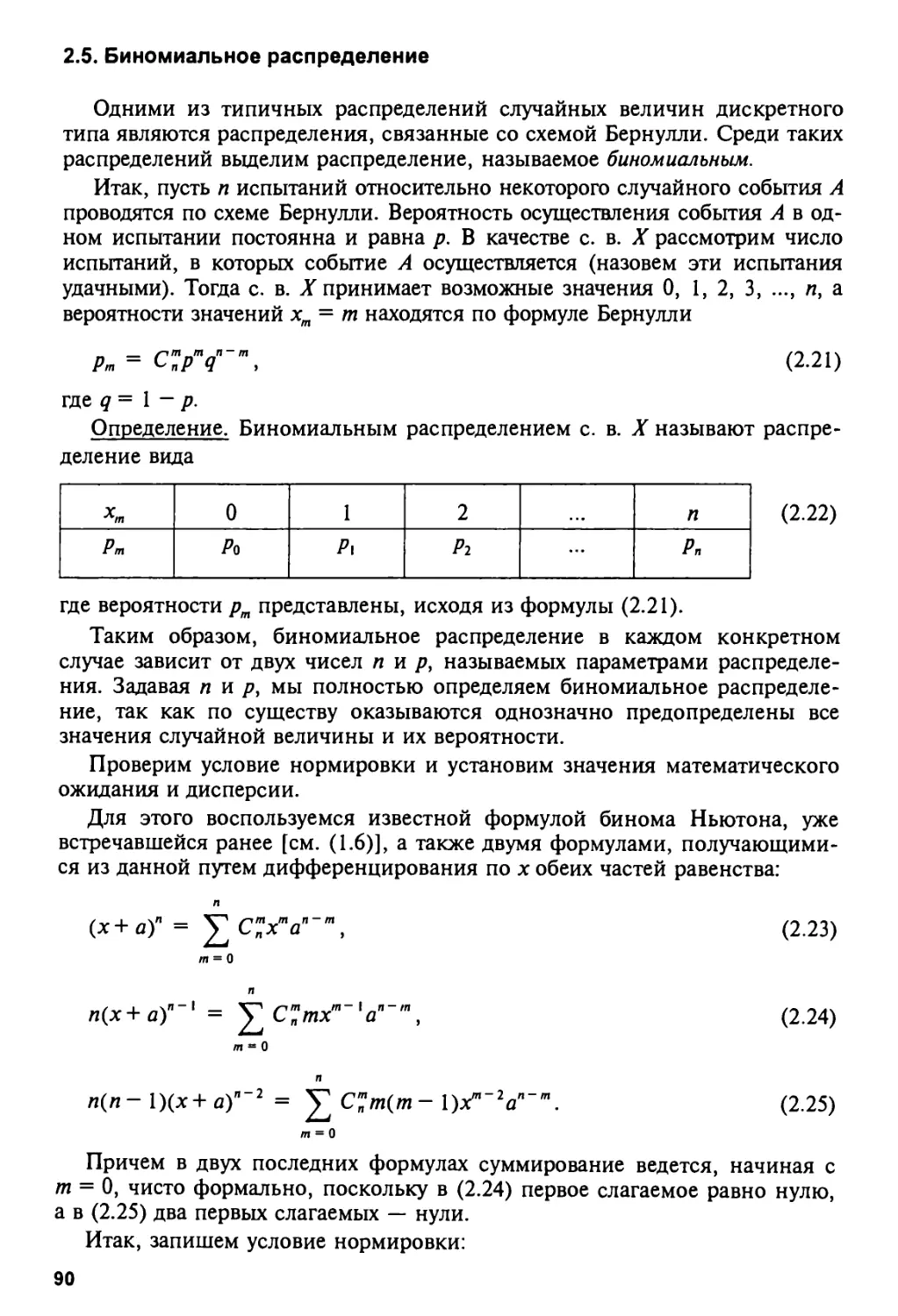

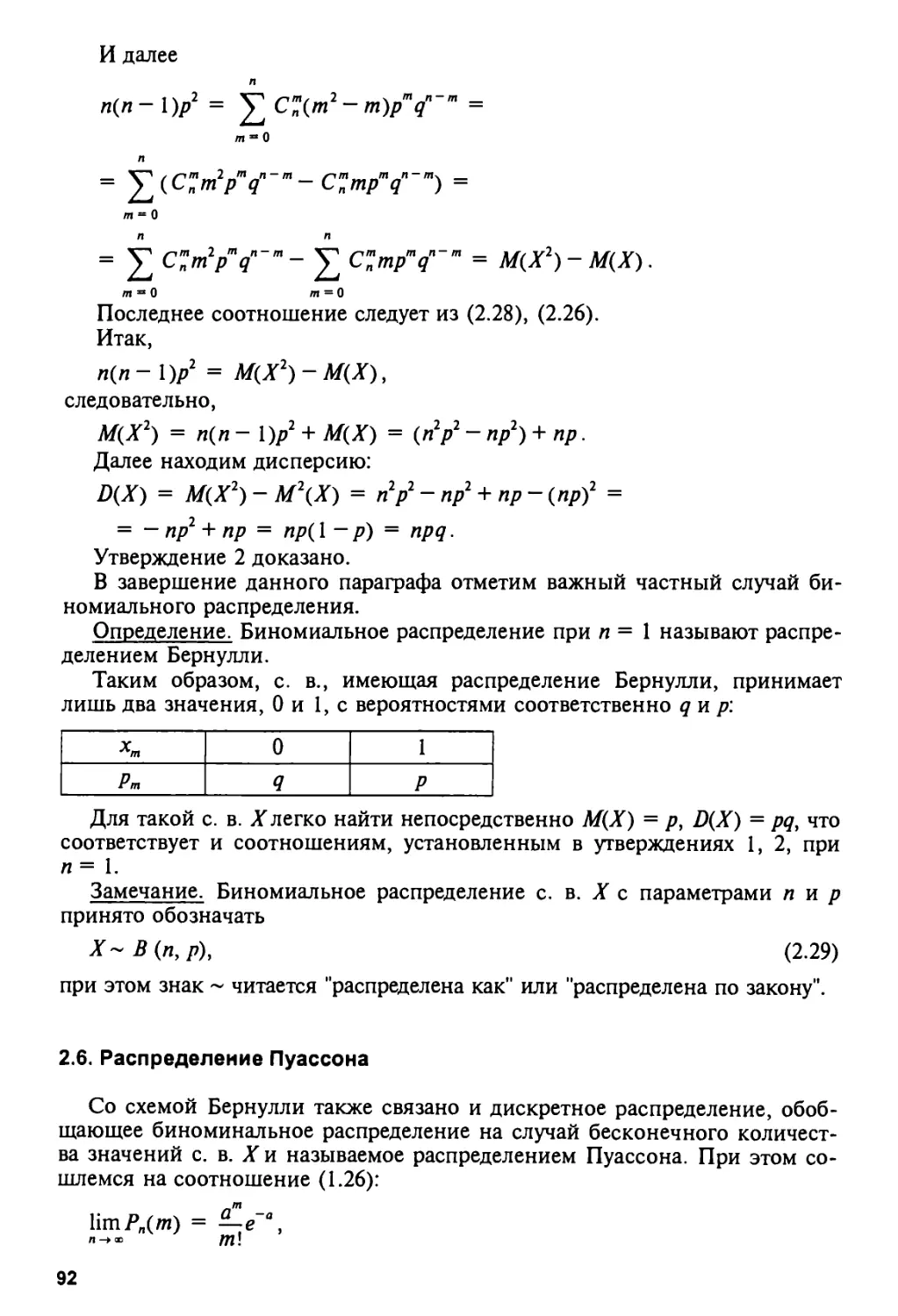

2.5. Биномиальное распределение 90

2.6. Распределение Пуассона 92

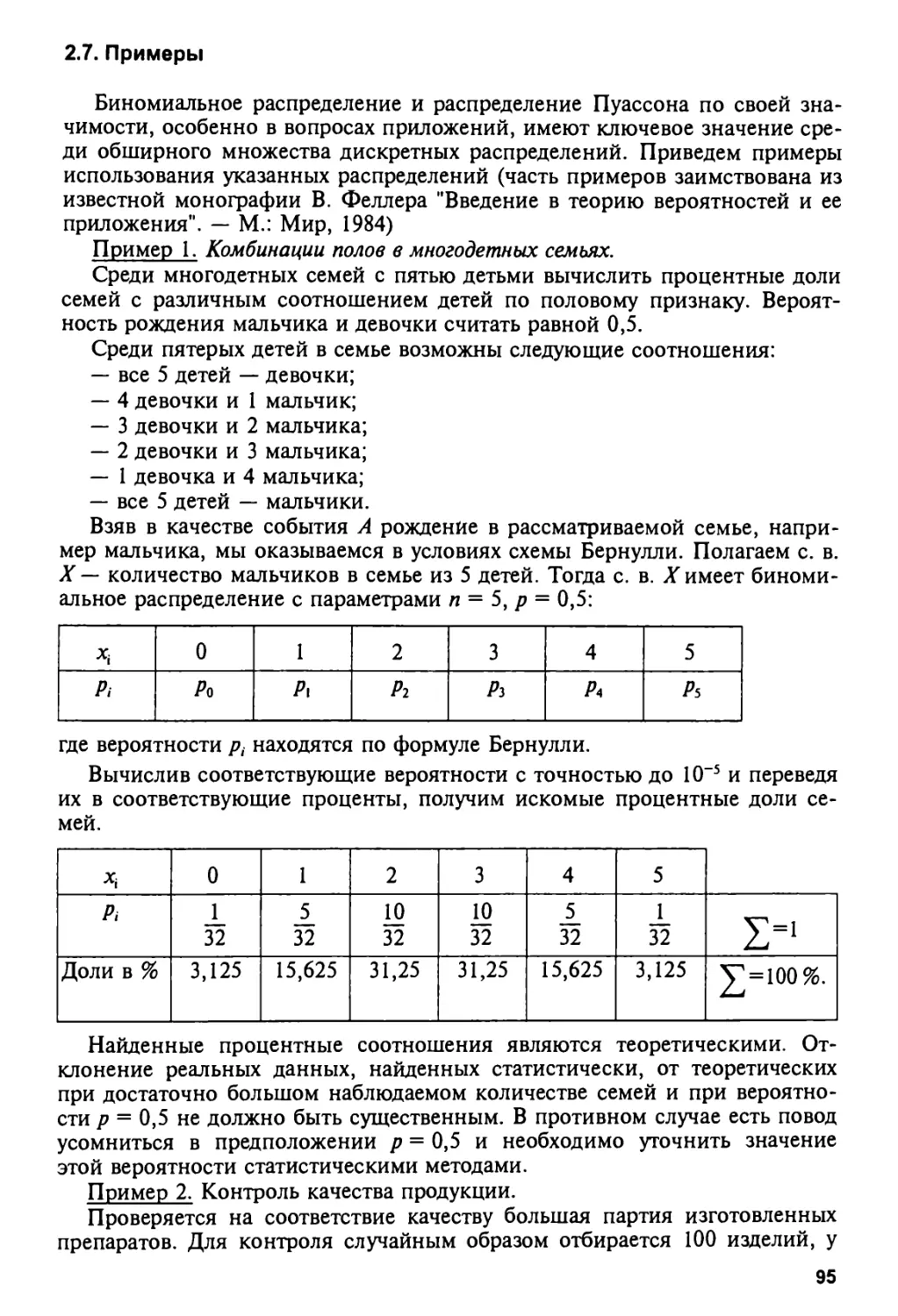

2.7. Примеры 95

2.8. Некоторые дискретные распределения 104

2.9. Непрерывные случайные величины 111

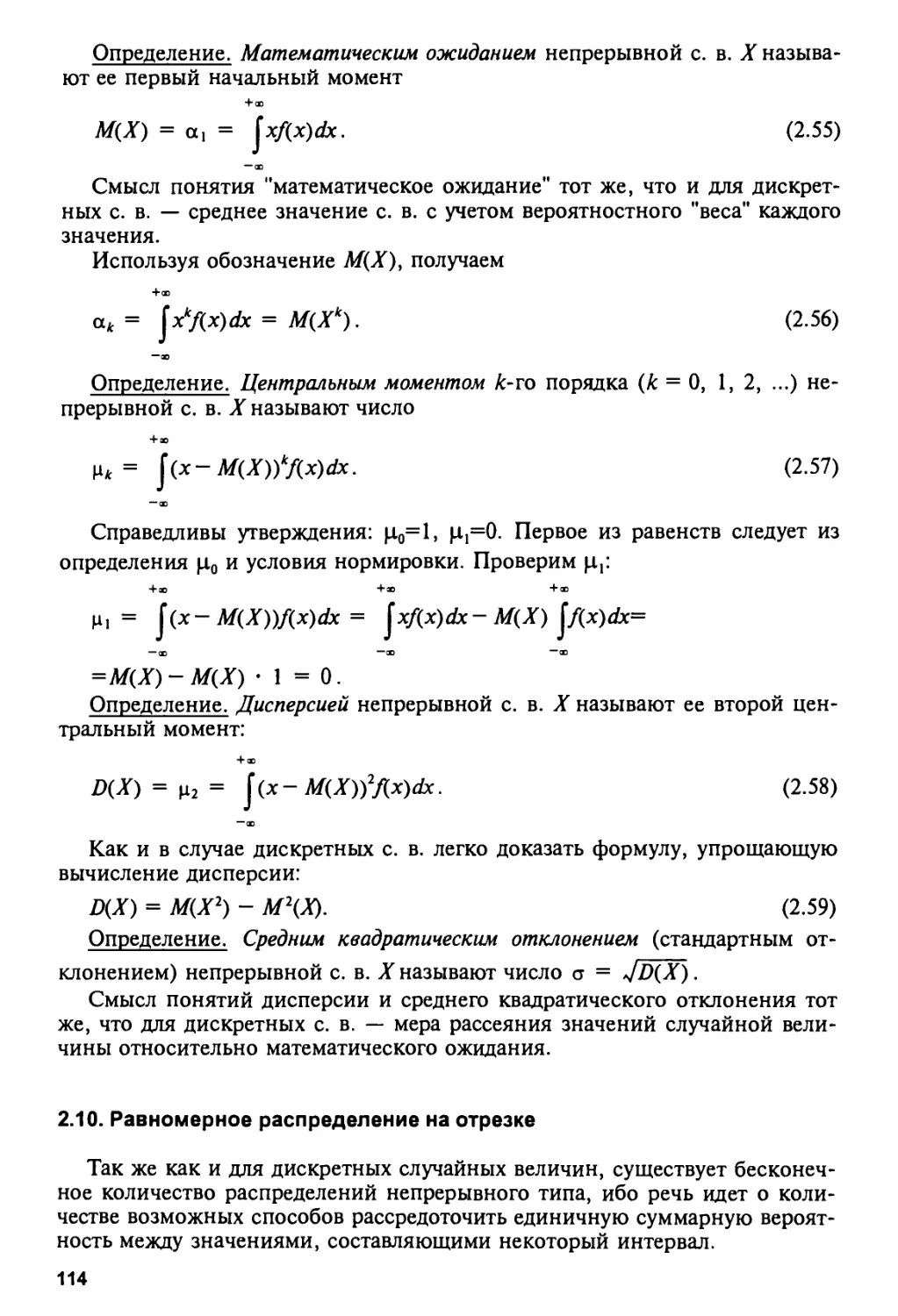

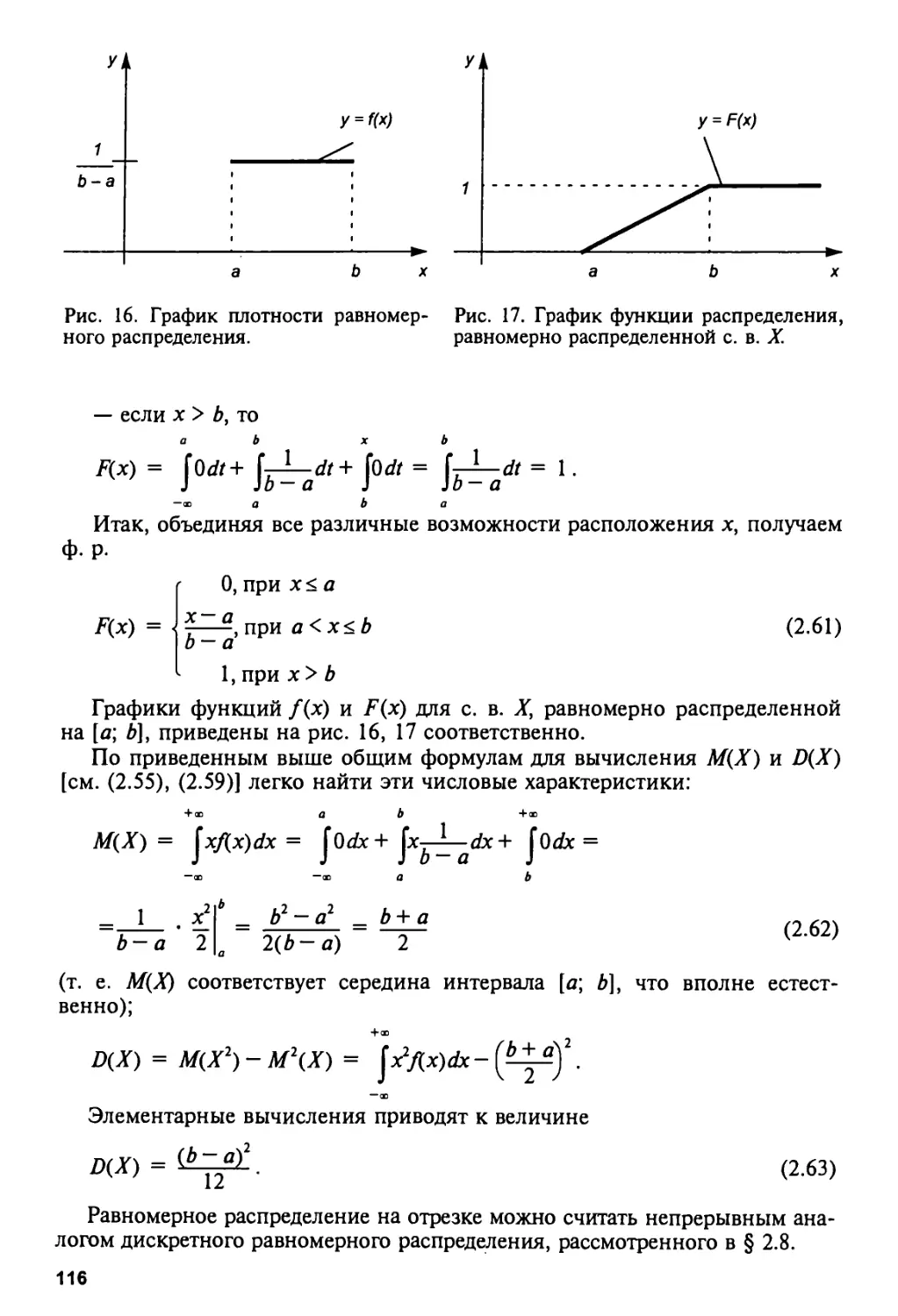

2.10. Равномерное распределение на отрезке 114

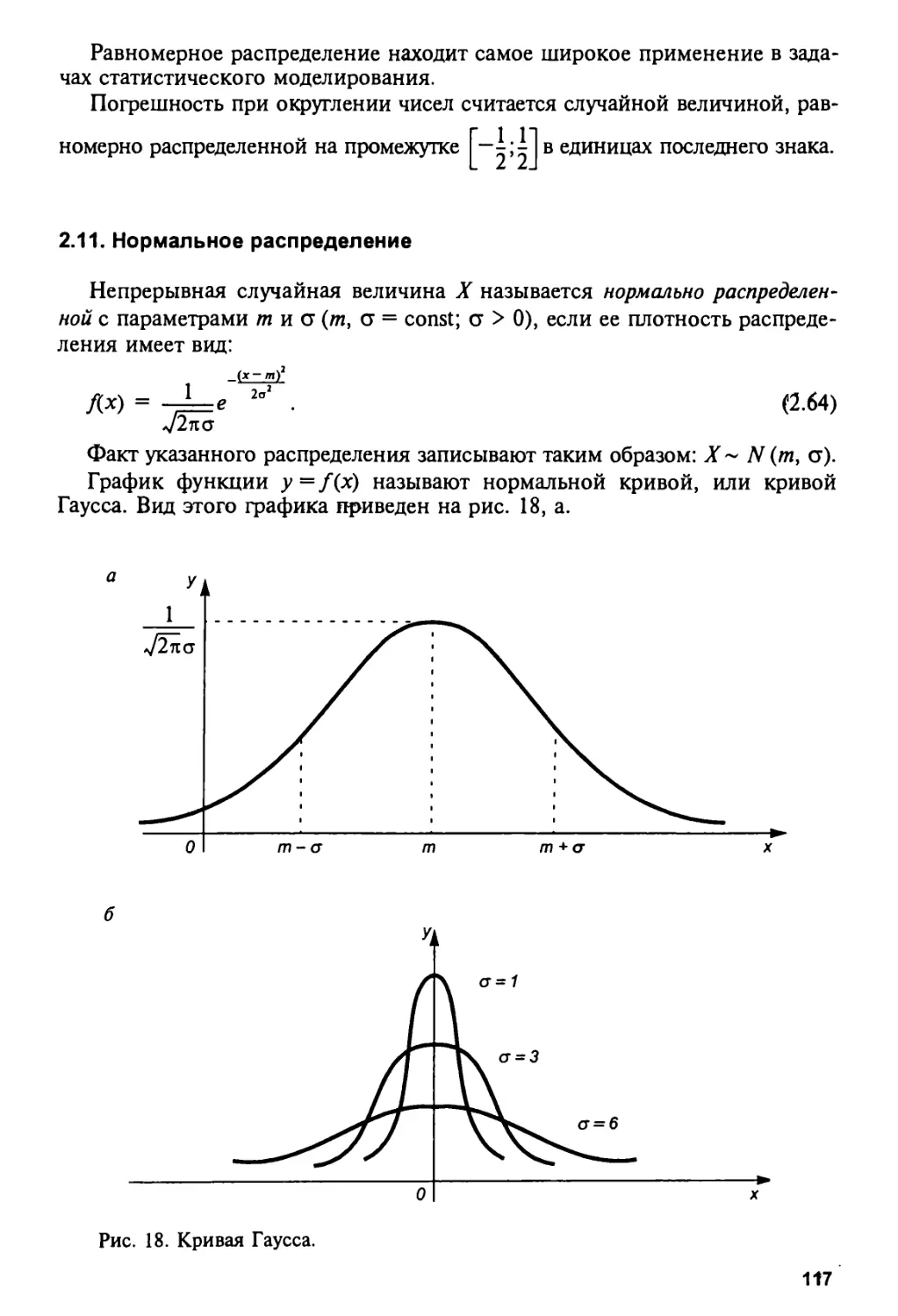

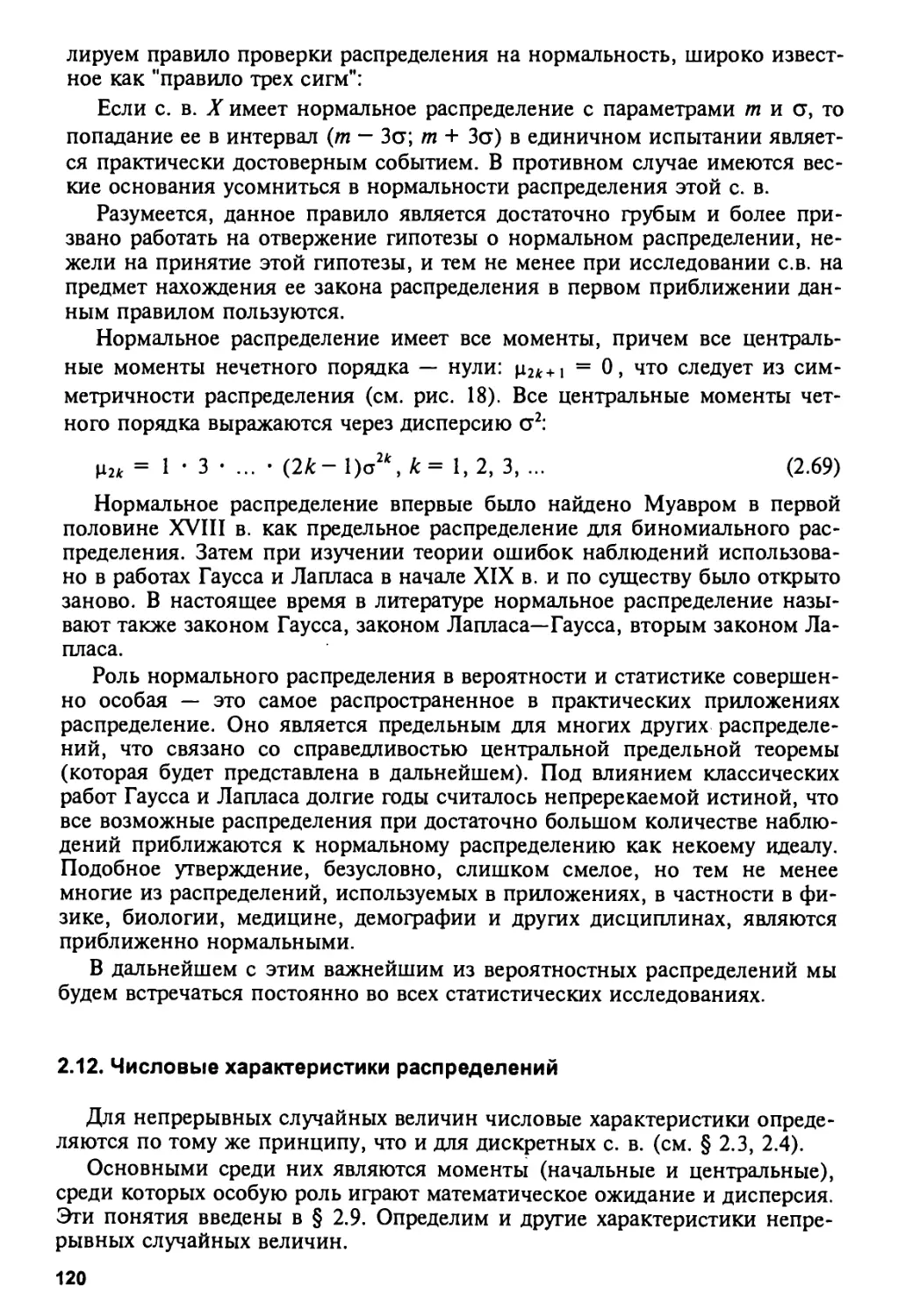

2.11. Нормальное распределение 117

2.12. Числовые характеристики распределений 120

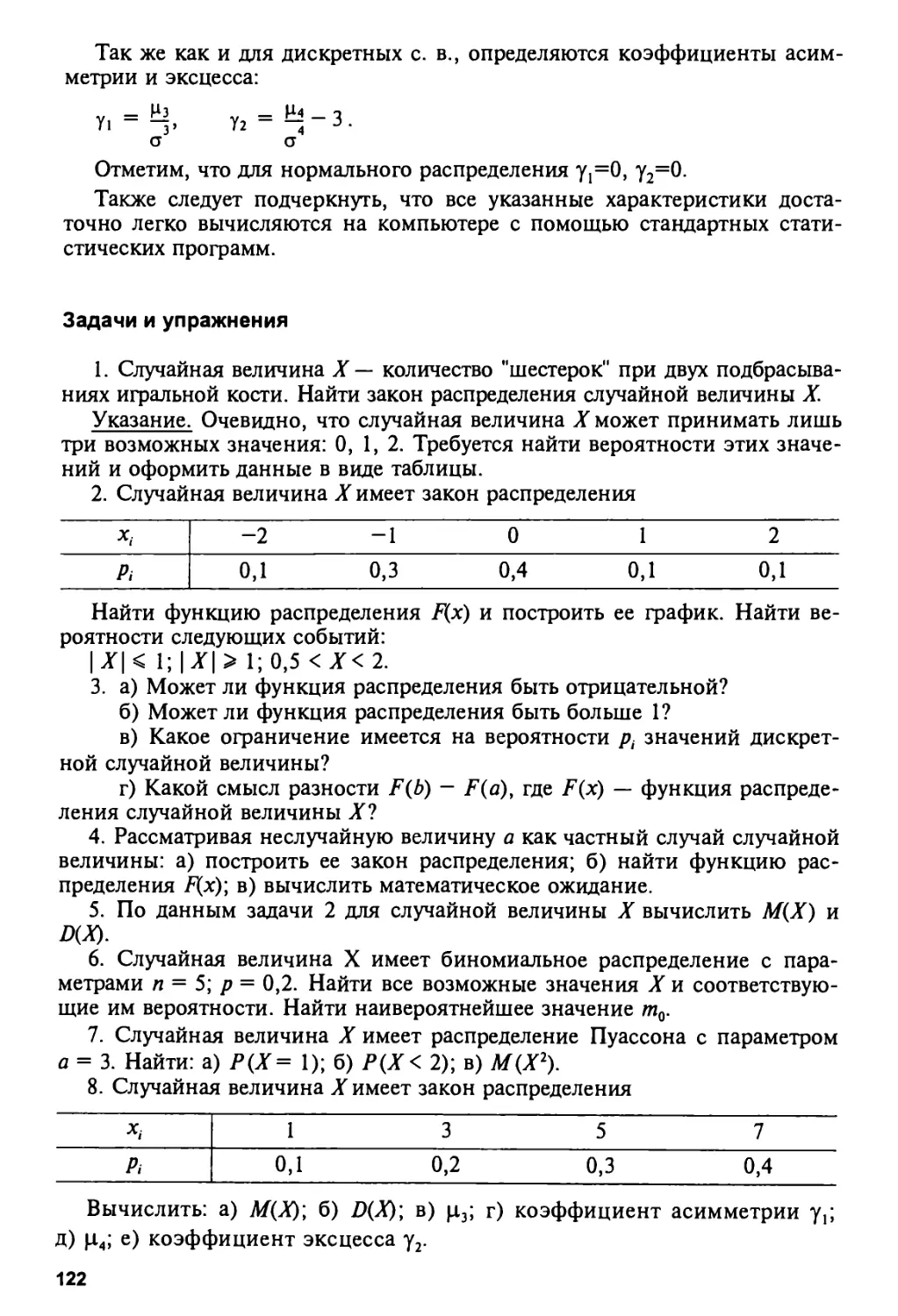

Задачи и упражнения 122

4

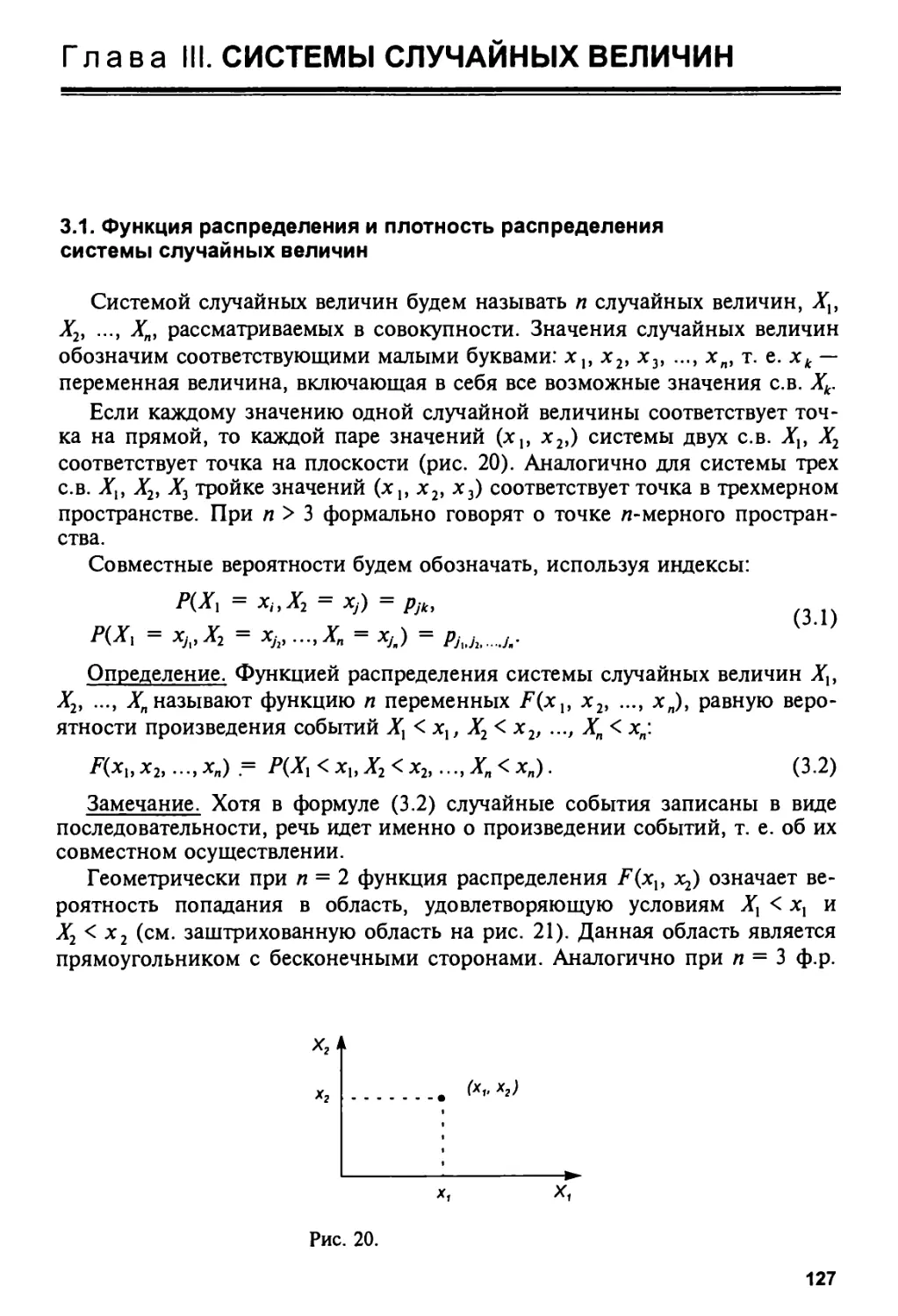

Глава III. СИСТЕМЫ СЛУЧАЙНЫХ ВЕЛИЧИН 127

3.1. Функция распределения и плотность распределения

системы случайных величин 127

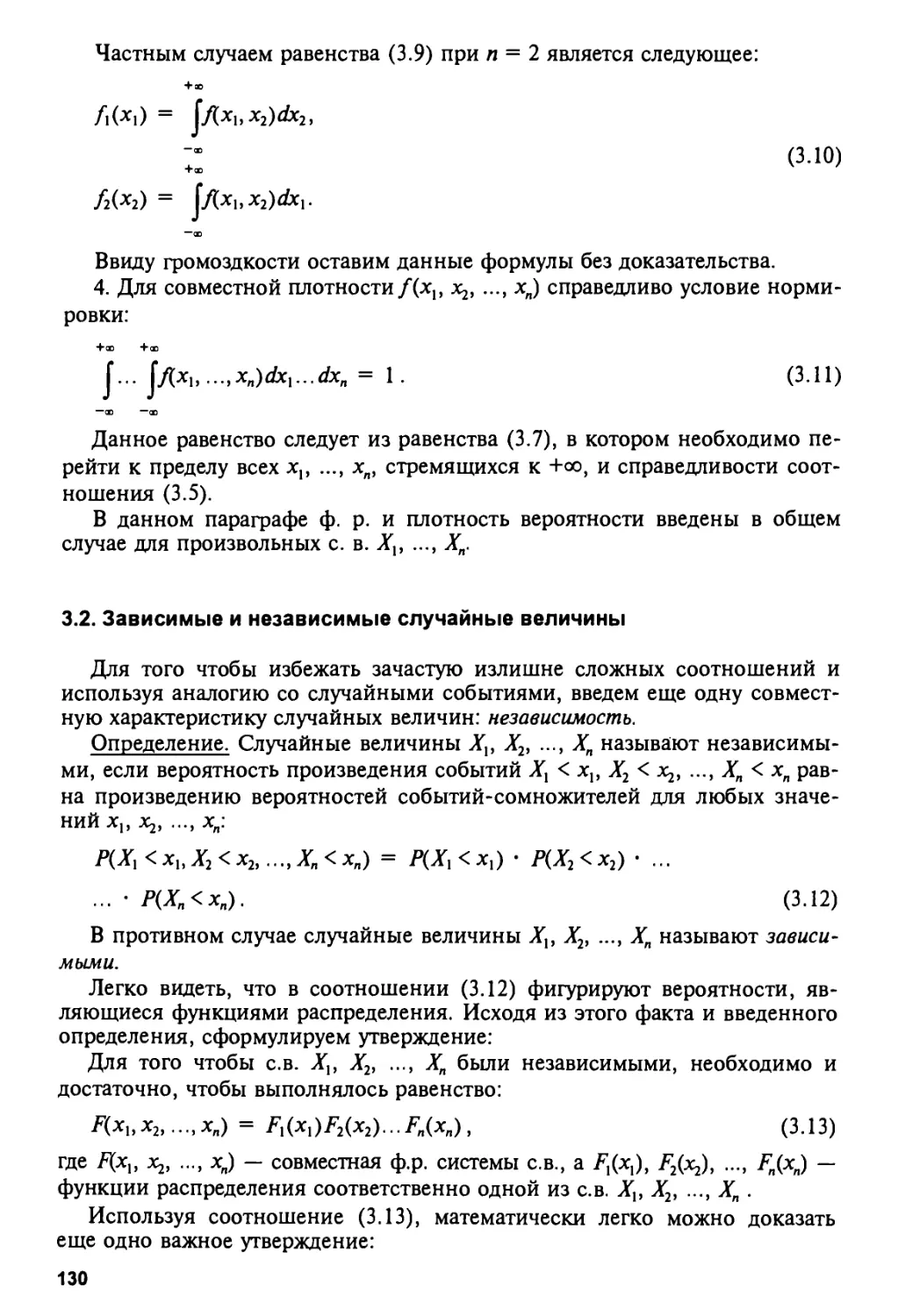

3.2. Зависимые и независимые случайные величины 130

3.3. Моменты системы случайных величин. Ковариация 131

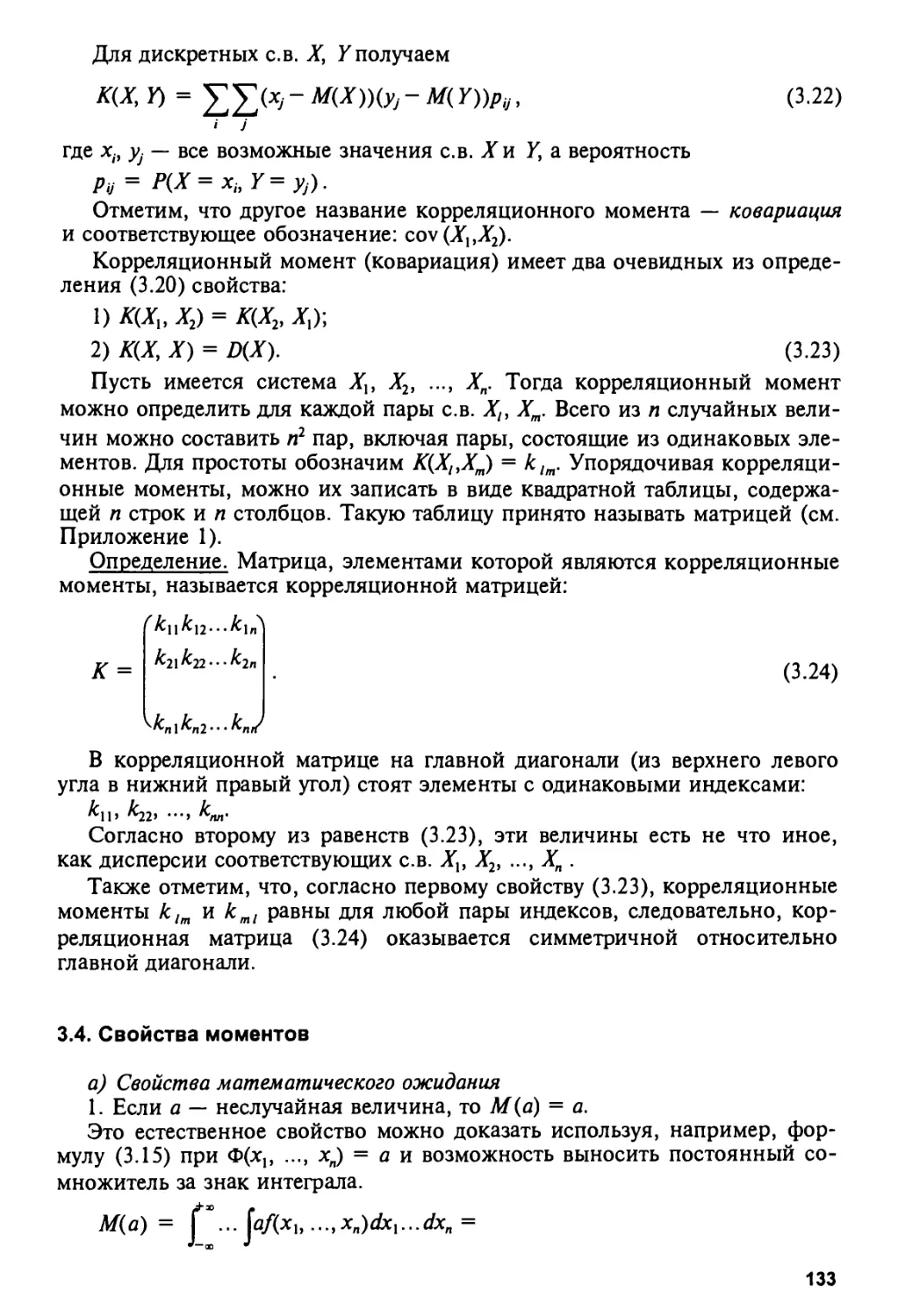

3.4. Свойства моментов 133

3.5. Независимость и некоррелированность случайных величин.

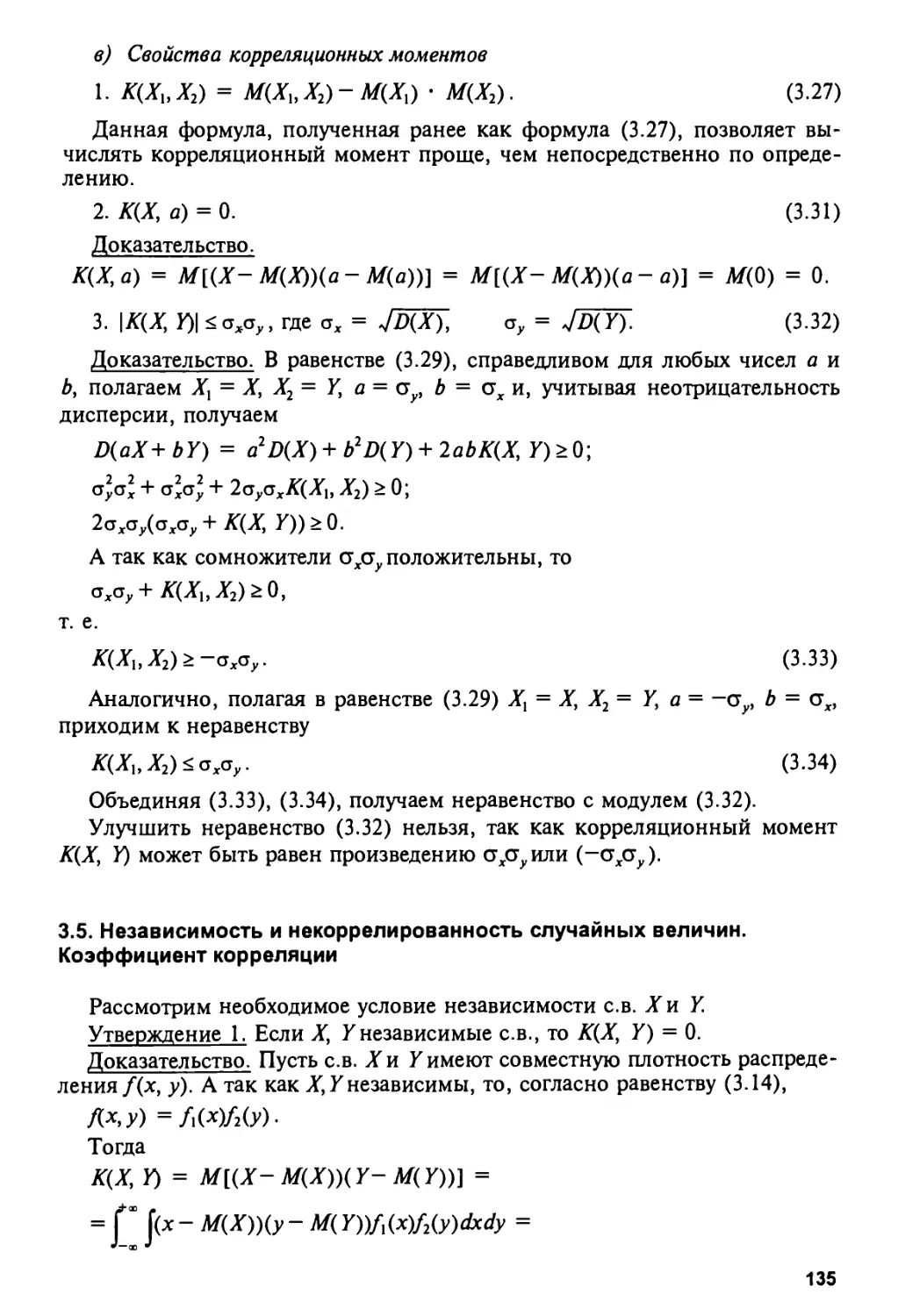

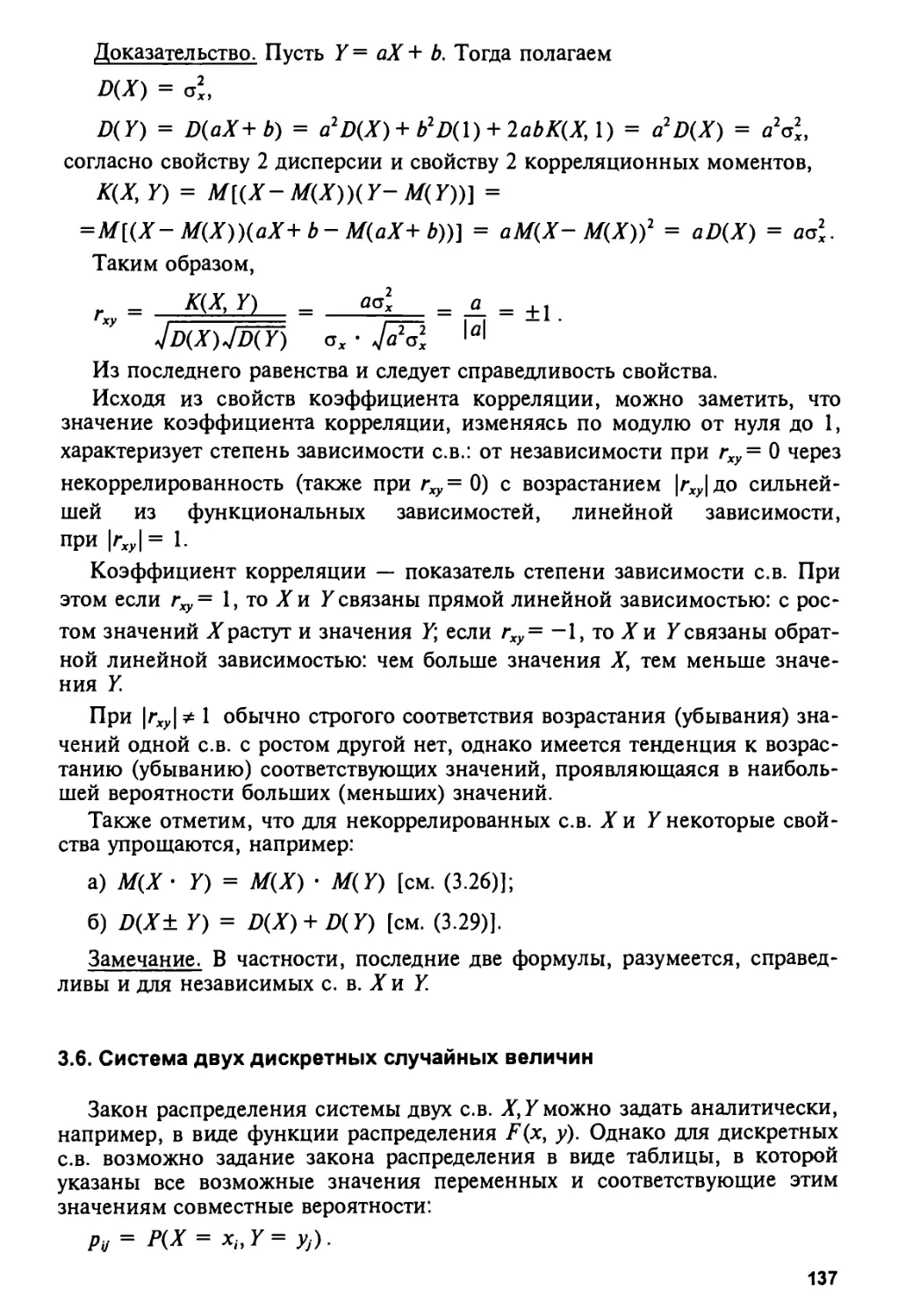

Коэффициент корреляции 135

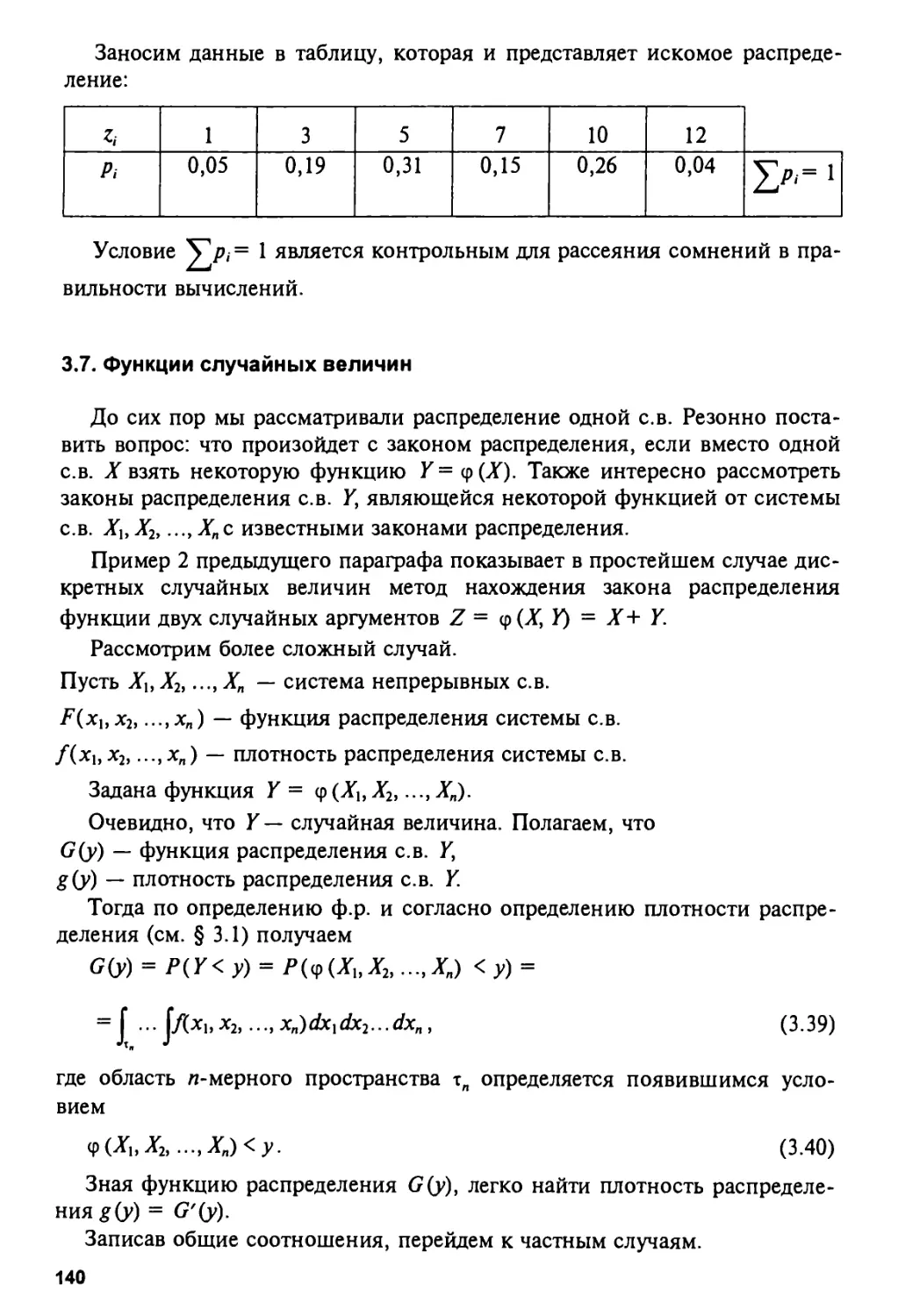

3.6. Система двух дискретных случайных величин 137

3.7. Функции случайных величин 140

3.8. Специальные распределения (Пирсона, Стьюдента, Фишера) 144

3.9. Условное распределение. Регрессия. Среди еквадратическая регрессия . . 148

3.10. Предельные теоремы 153

Задачи и упражнения 158

Глава IV ВЫБОРОЧНЫЙ МЕТОД 162

4.1. Предмет и задачи 162

4.2. Основные понятия выборочного метода 163

4.3. Выборочное распределение и его характеристики 164

4.4. Преобразования выборок 170

4.5. Графический метод представления статистических данных 173

4.6. Методика выравнивания статистических рядов 180

4.7. Критерии согласия 183

4.8. Практический пример применения критерия согласия (закон Менделя) . 187

4.9. Приближенная проверка гипотезы о нормальном распределении 189

Задачи и упражнения 191

Глава V ОЦЕНКИ ПАРАМЕТРОВ РАСПРЕДЕЛЕНИЯ 196

5.1. Особенности малых выборок. Точечные оценки 196

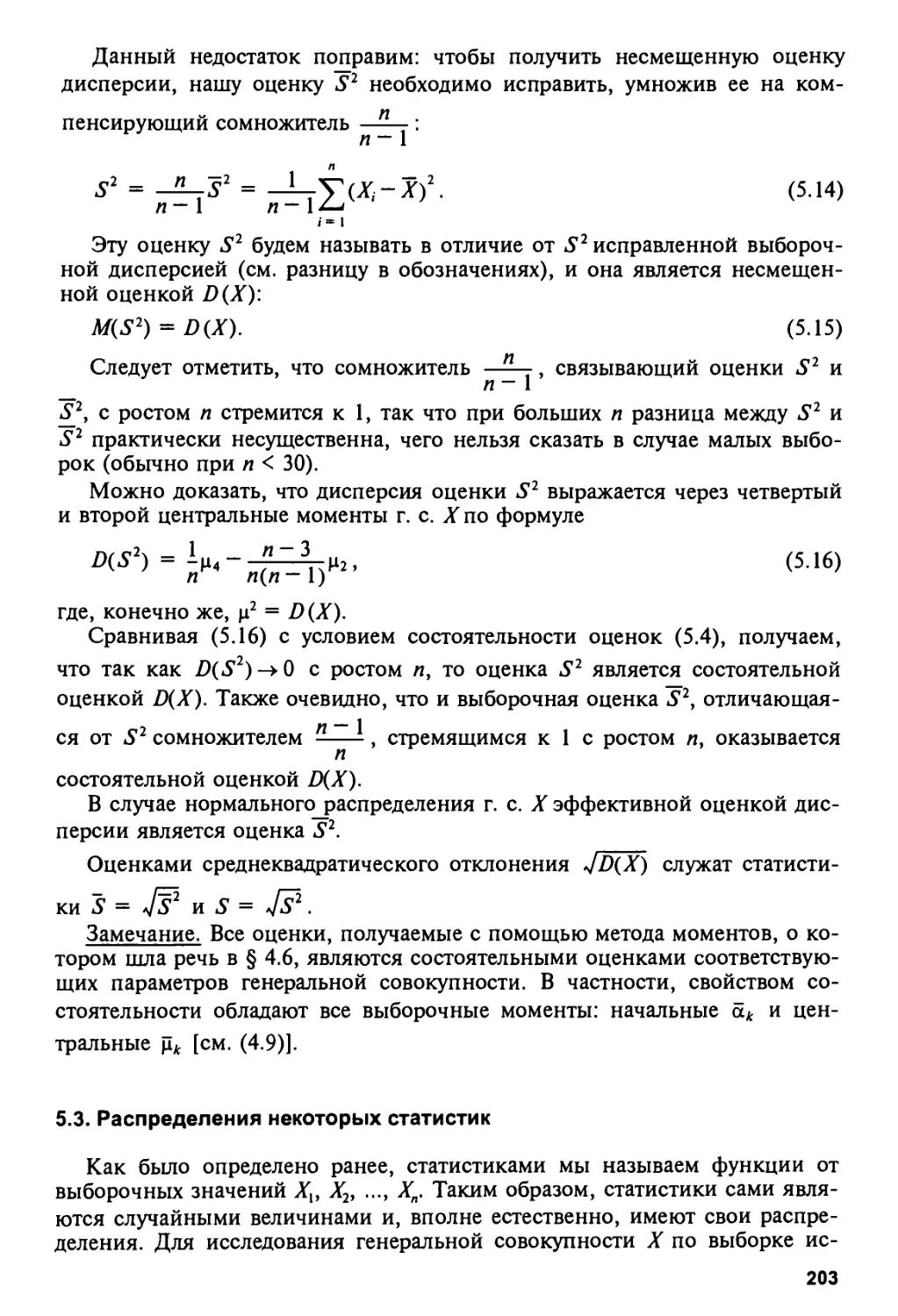

5.2. Точечные оценки для математического ожидания и дисперсии 199

5.3. Распределения некоторых статистик 203

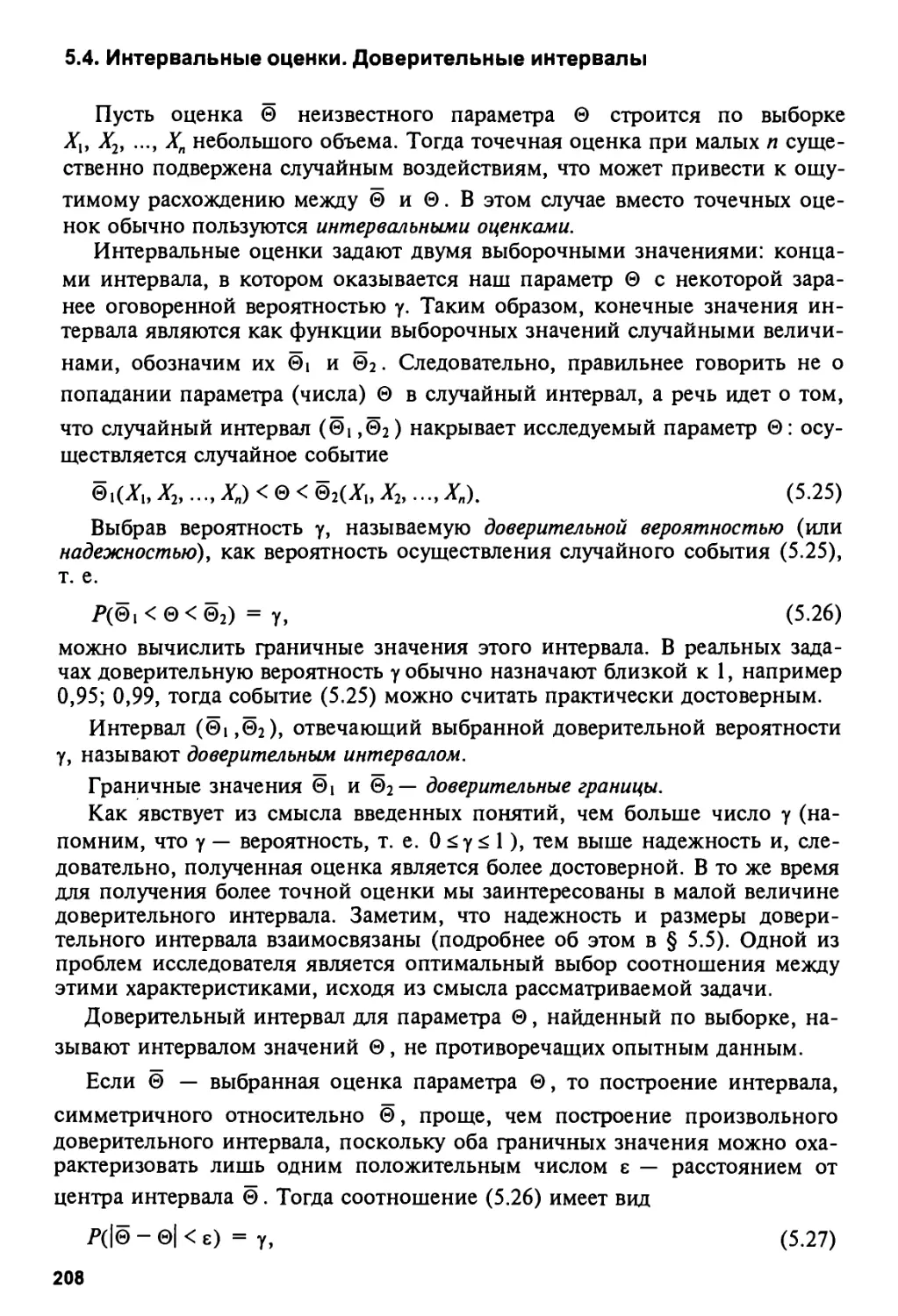

5.4. Интервальные оценки. Доверительные интервалы 208

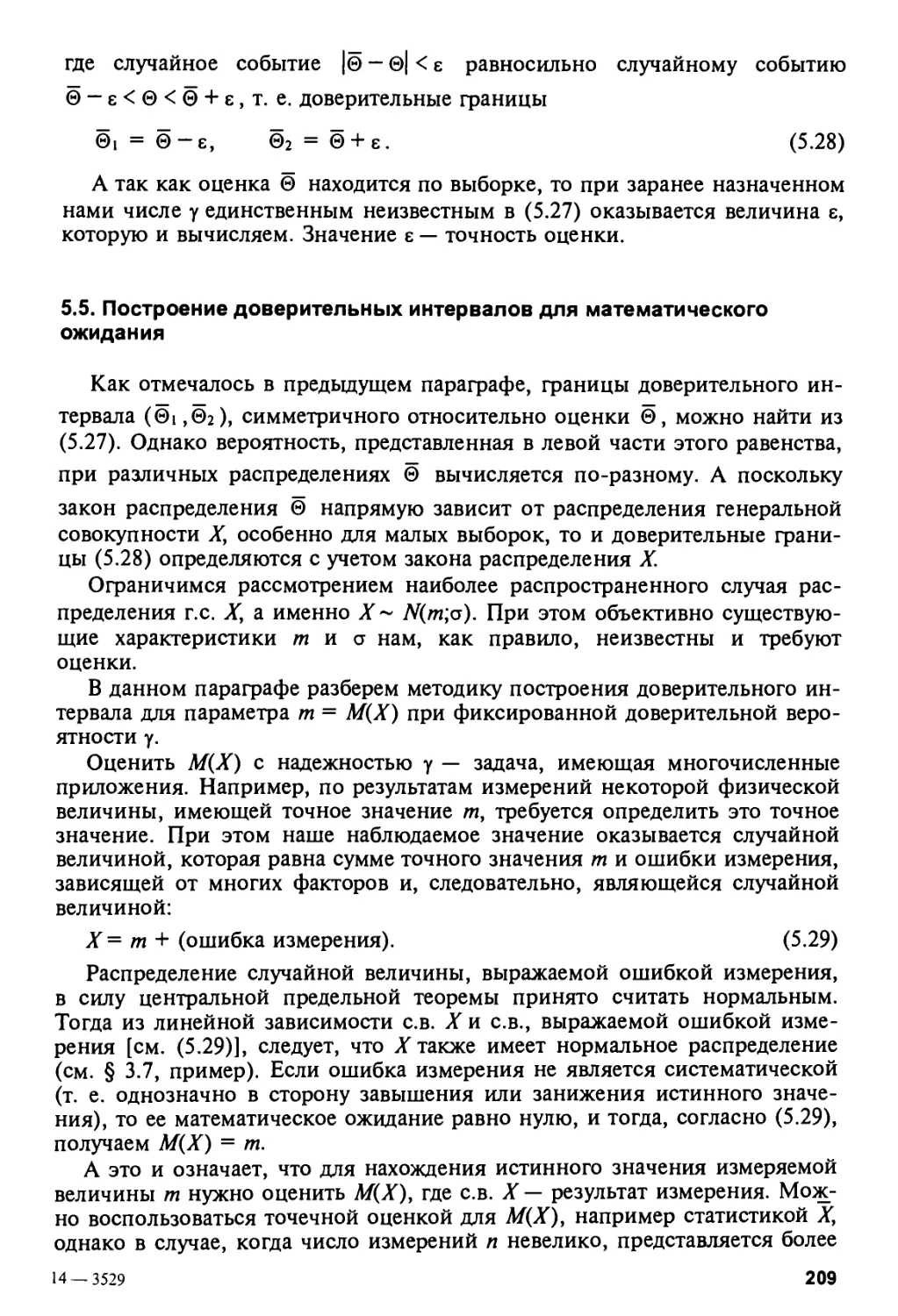

5.5. Построение доверительных интервалов для математического ожидания . 209

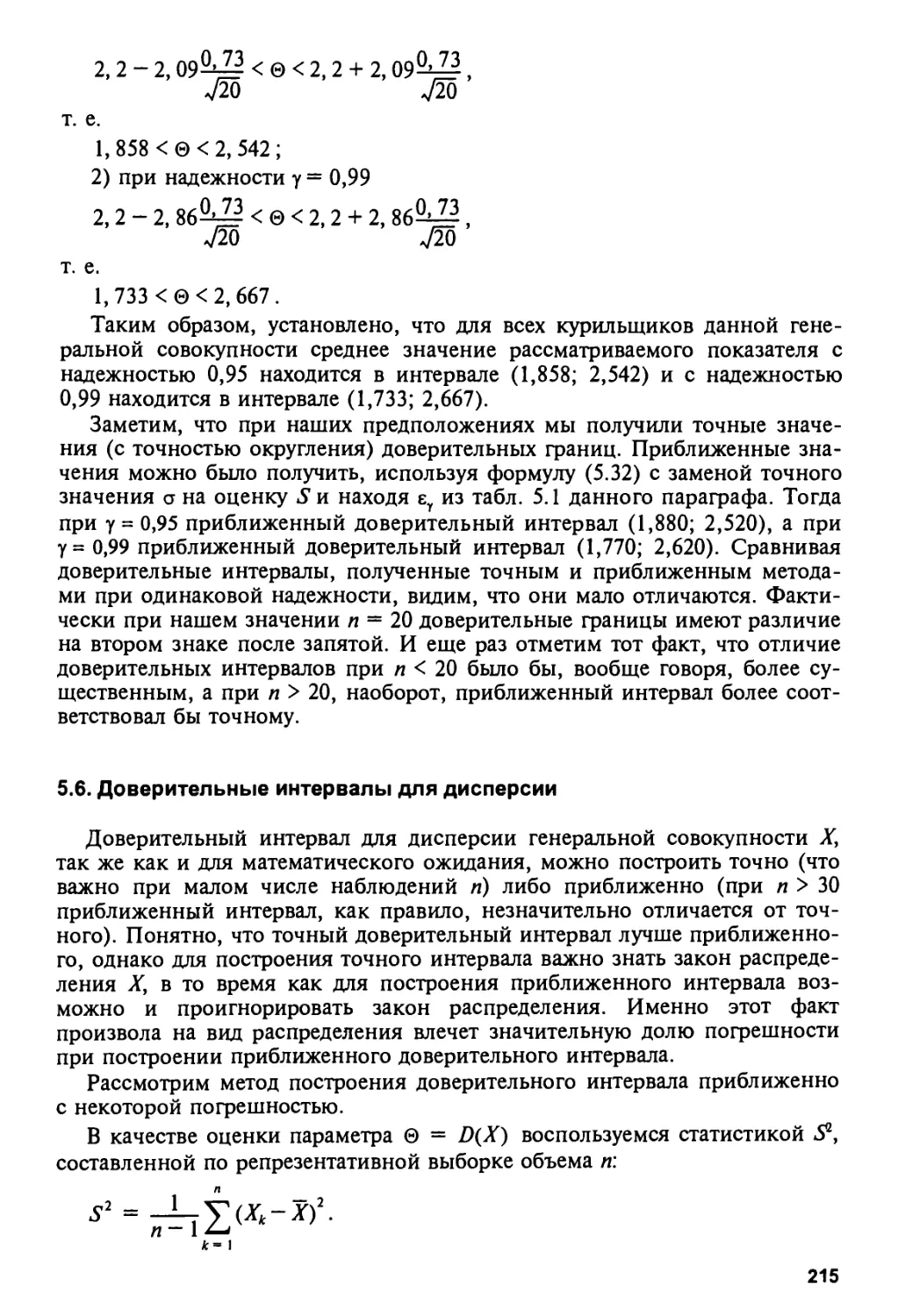

5.6. Доверительные интервалы для дисперсии 215

5.7. Доверительный интервал для разности средних 220

5.8. Оценка вероятности по частоте 222

5.9. Ошибка выборки. Оптимальная численность выборки 227

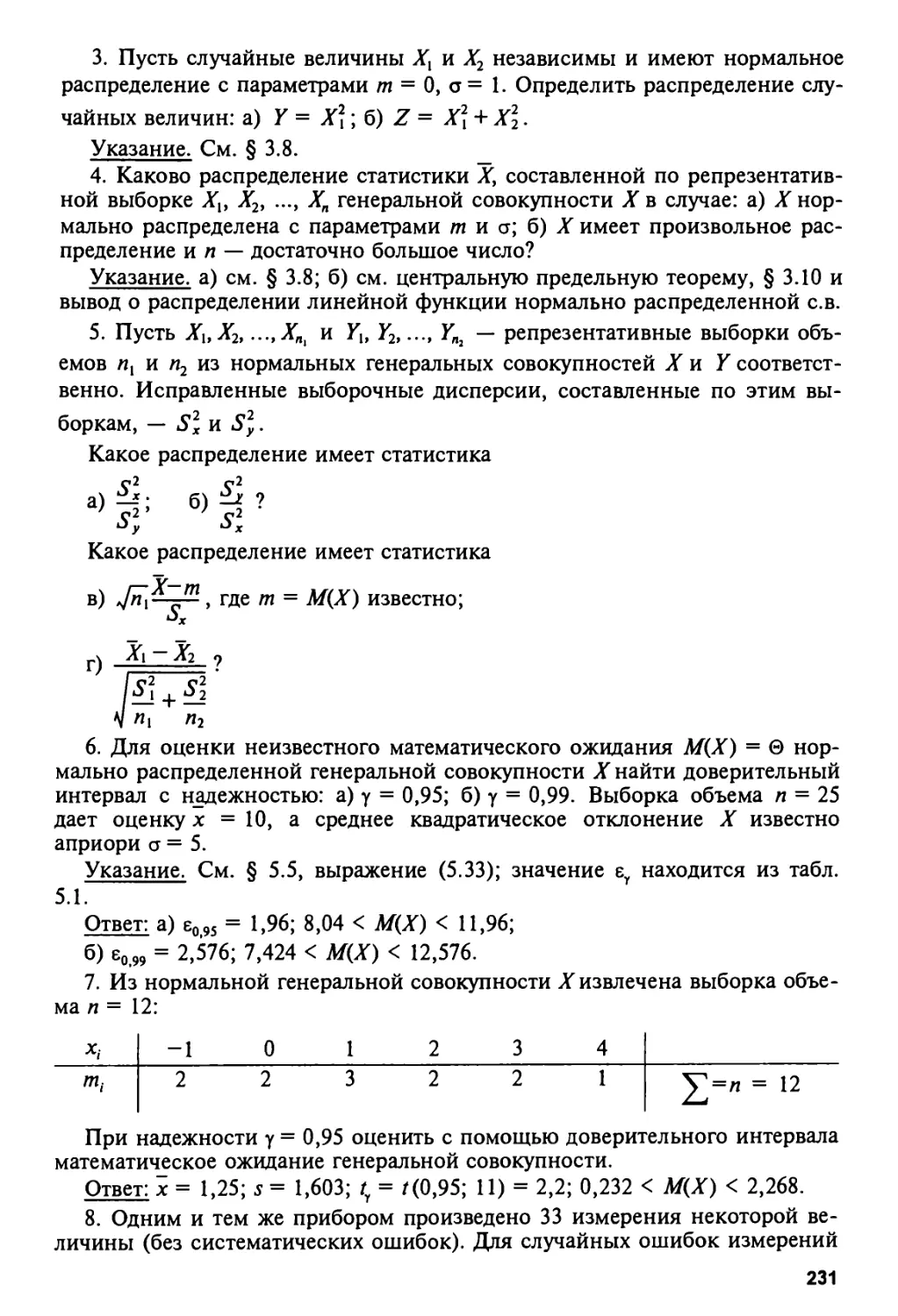

Задачи и упражнения 230

Глава VI ПРОВЕРКА СТАТИСТИЧЕСКИХ ГИПОТЕЗ 235

6.1. Статистическая гипотеза 235

6.2. Статистические критерии 238

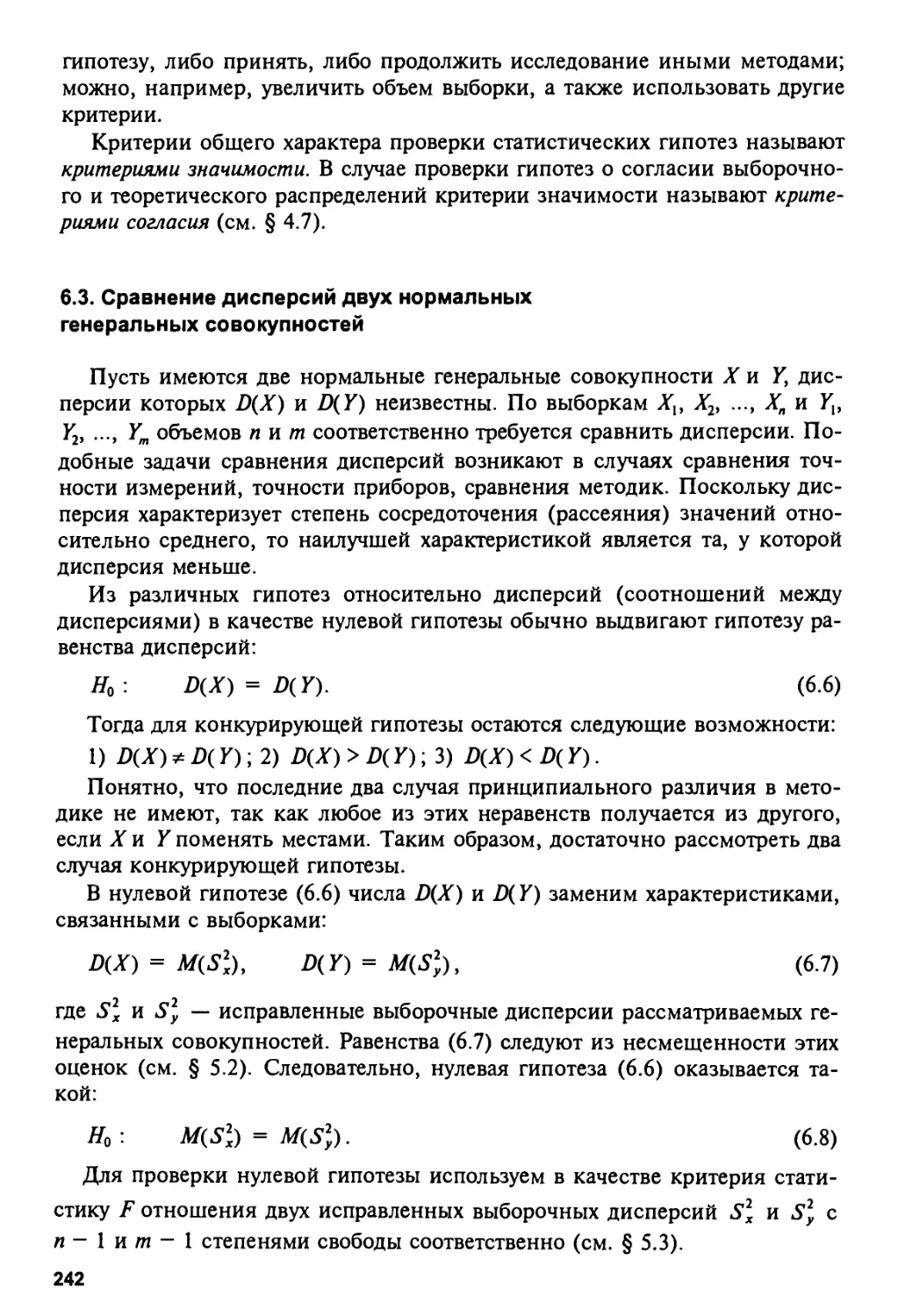

6.3. Сравнение дисперсий двух нормальных генеральных совокупностей . . . 242

6.4. Проверка гипотезы о равенстве неизвестной дисперсии

конкретному значению 246

6.5. Сравнение средних двух нормальных генеральных совокупностей

при известных дисперсиях 251

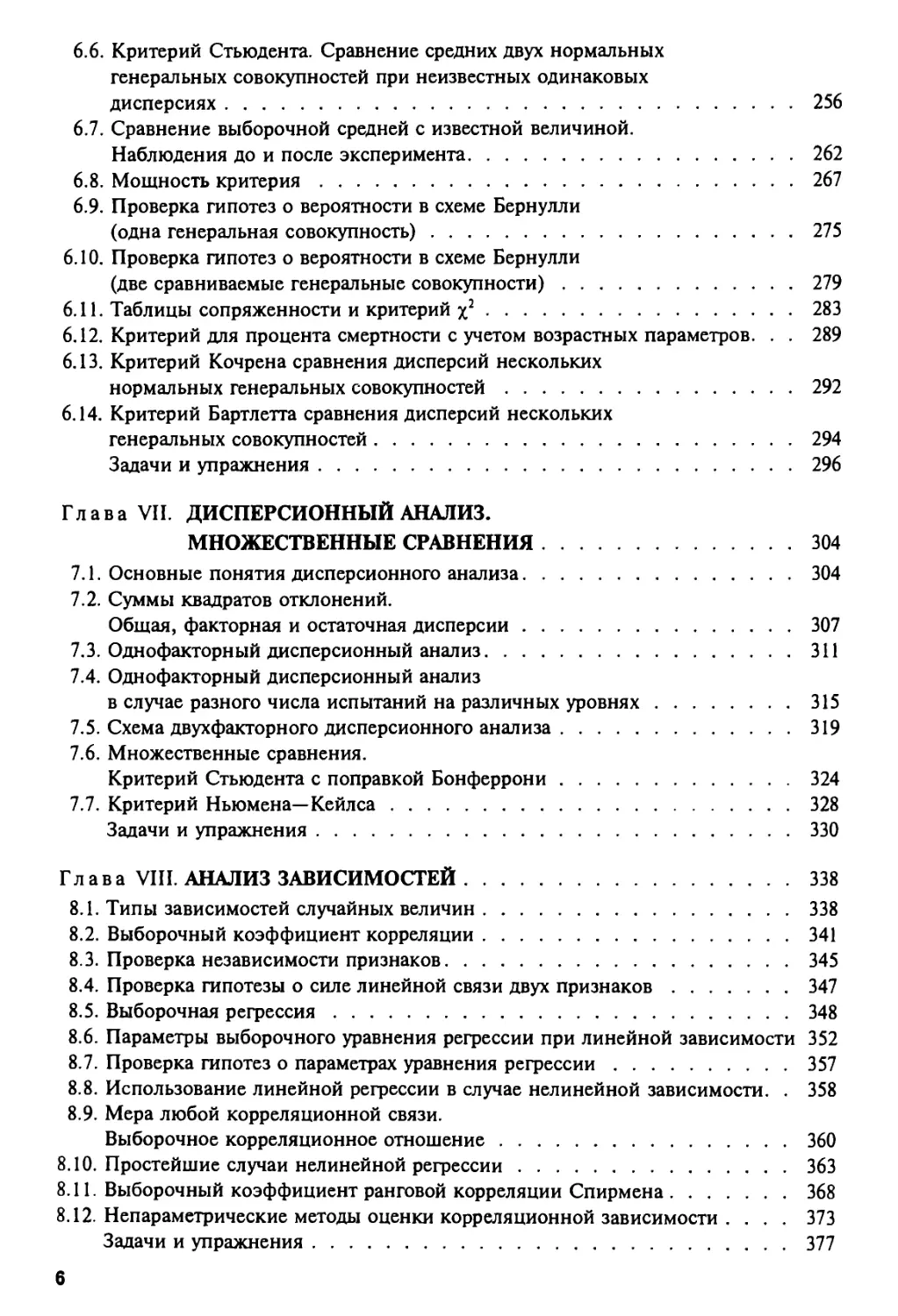

5

6.6. Критерий Стьюдента. Сравнение средних двух нормальных

генеральных совокупностей при неизвестных одинаковых

дисперсиях 256

6.7. Сравнение выборочной средней с известной величиной.

Наблюдения до и после эксперимента 262

6.8. Мощность критерия 267

6.9. Проверка гипотез о вероятности в схеме Бернулли

(одна генеральная совокупность) 275

6.10. Проверка гипотез о вероятности в схеме Бернулли

(две сравниваемые генеральные совокупности) 279

6.11. Таблицы сопряженности и критерий у} 283

6.12. Критерий для процента смертности с учетом возрастных параметров. . . 289

6.13. Критерий Кочрена сравнения дисперсий нескольких

нормальных генеральных совокупностей 292

6.14. Критерий Бартлетта сравнения дисперсий нескольких

генеральных совокупностей 294

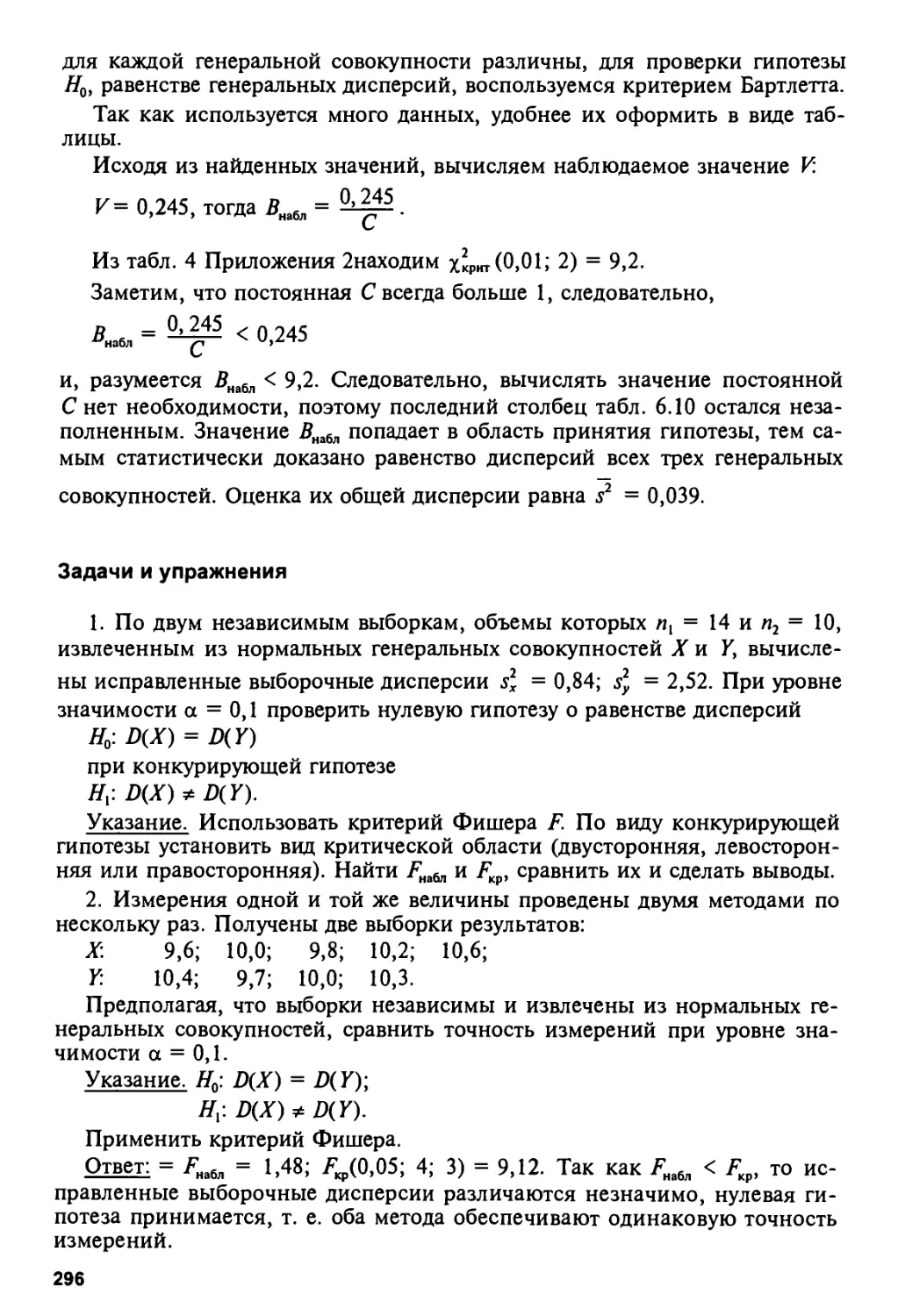

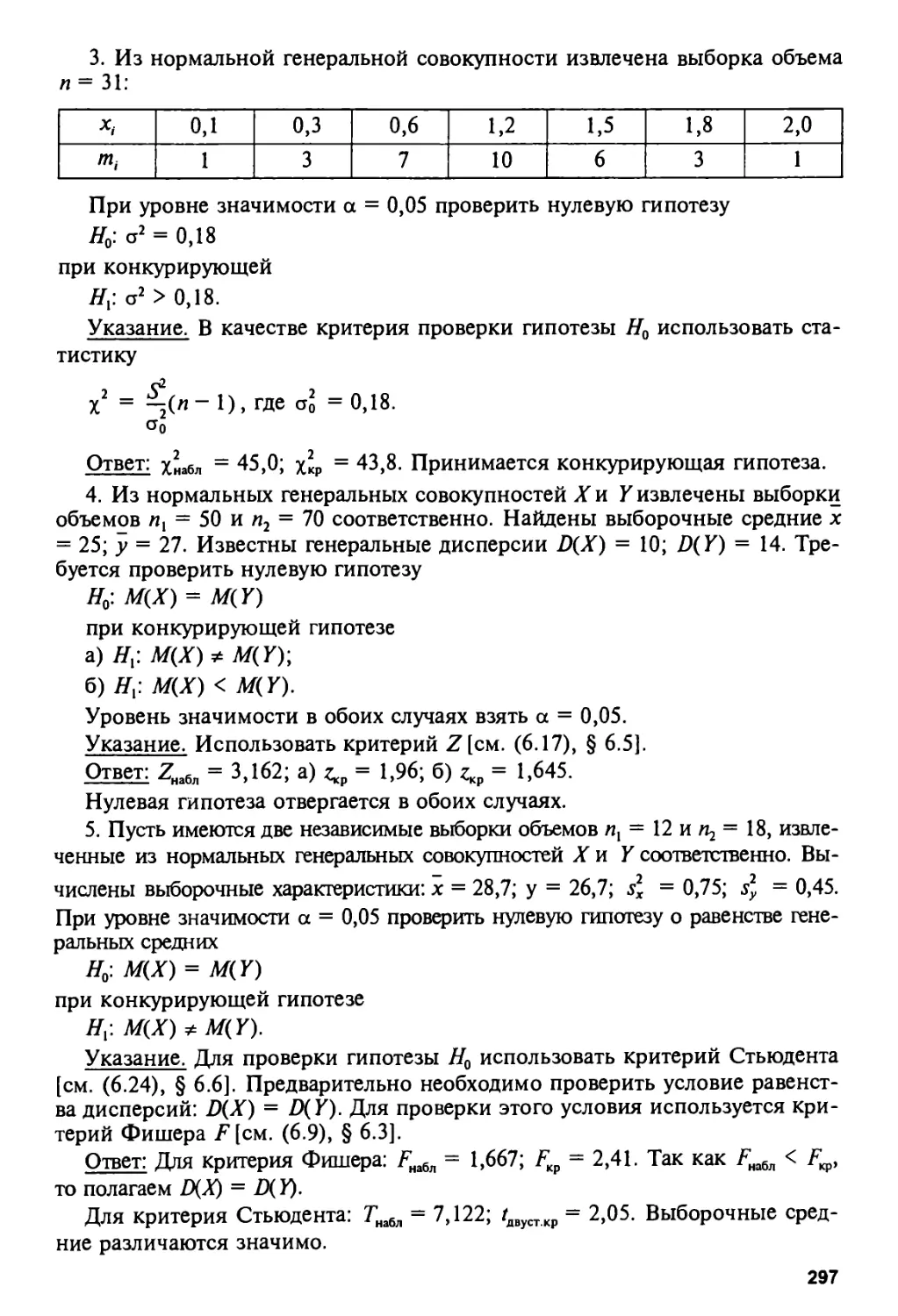

Задачи и упражнения 296

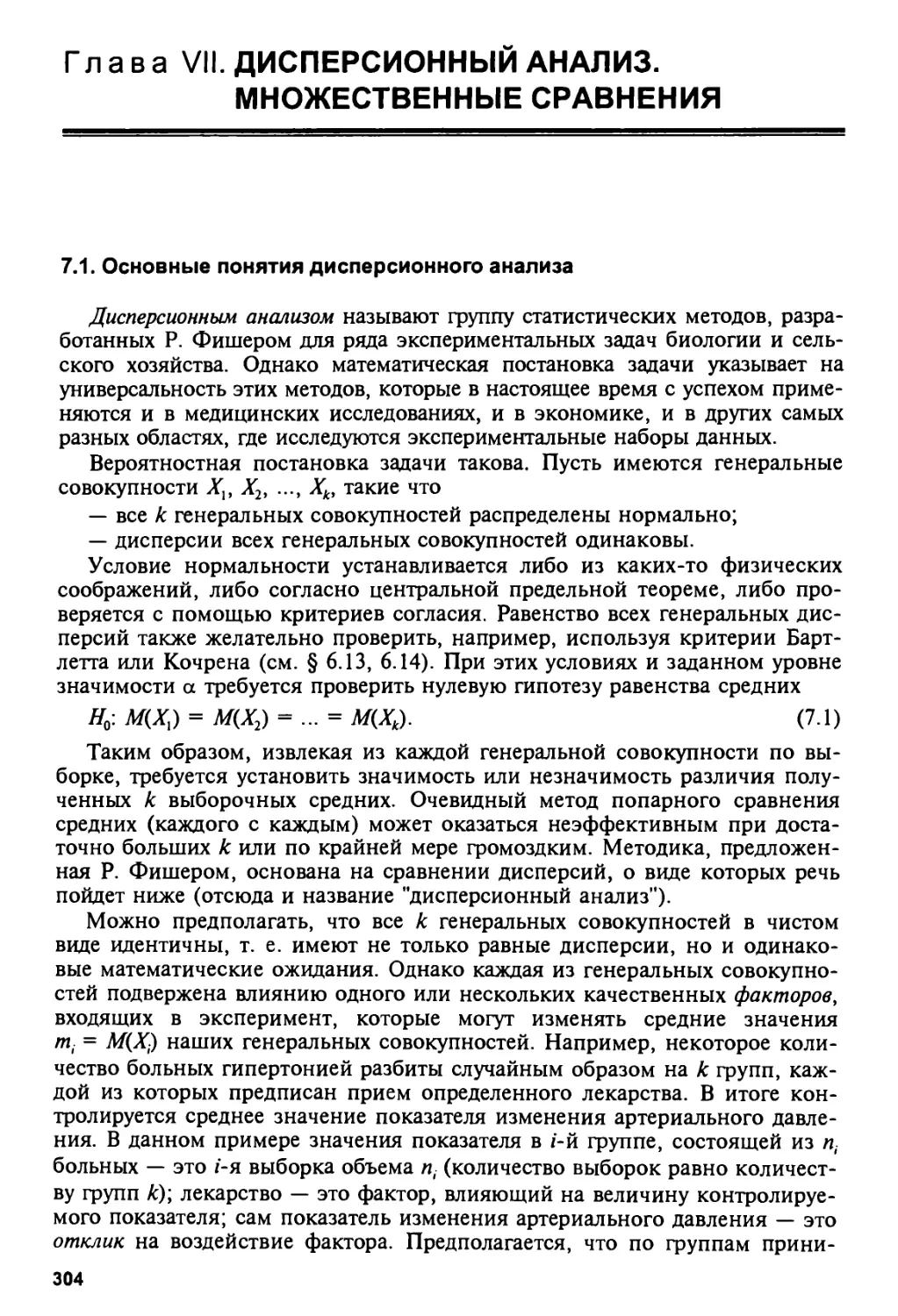

Глава VII. ДИСПЕРСИОННЫЙ АНАЛИЗ.

МНОЖЕСТВЕННЫЕ СРАВНЕНИЯ 304

7.1. Основные понятия дисперсионного анализа 304

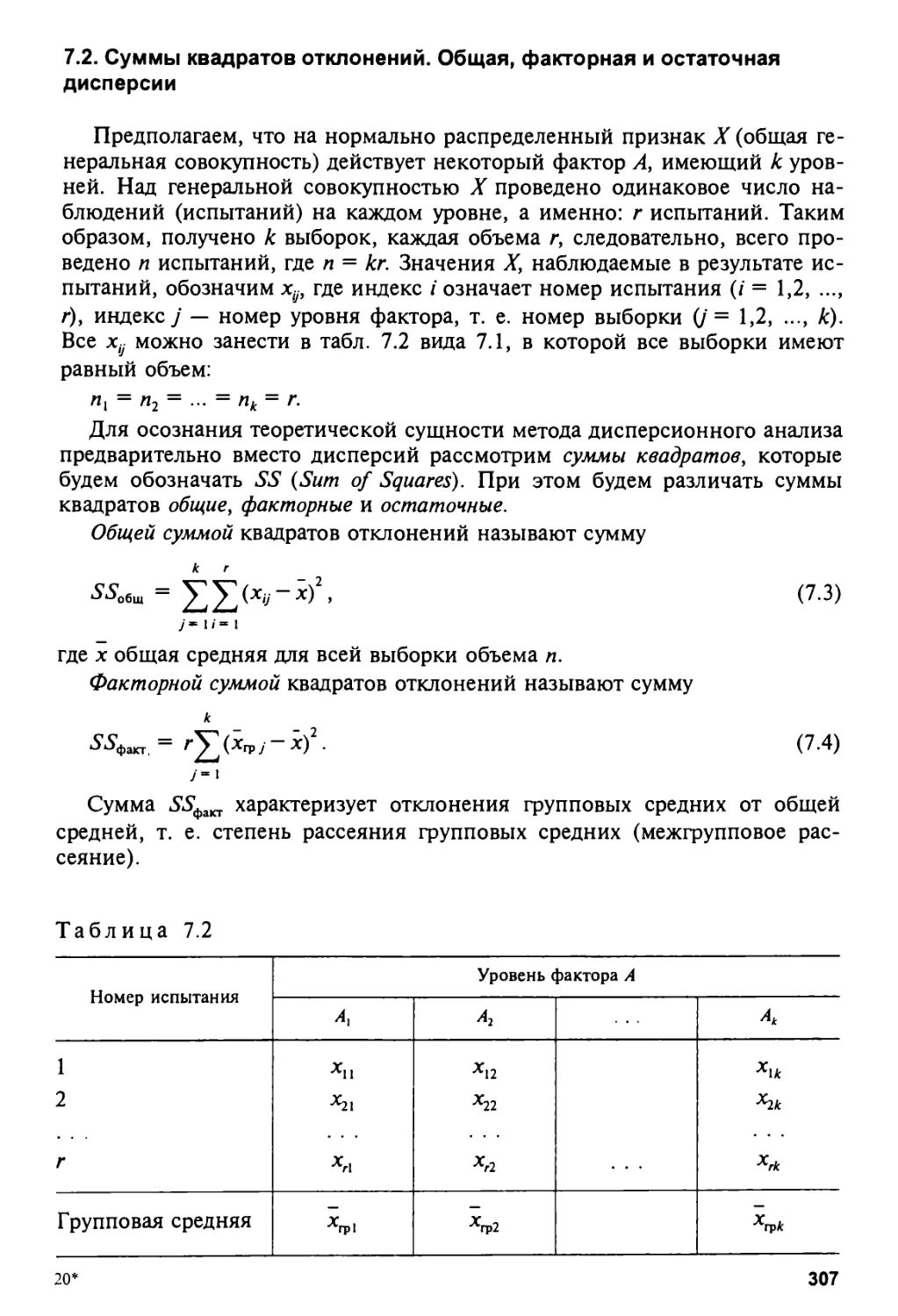

7.2. Суммы квадратов отклонений.

Общая, факторная и остаточная дисперсии 307

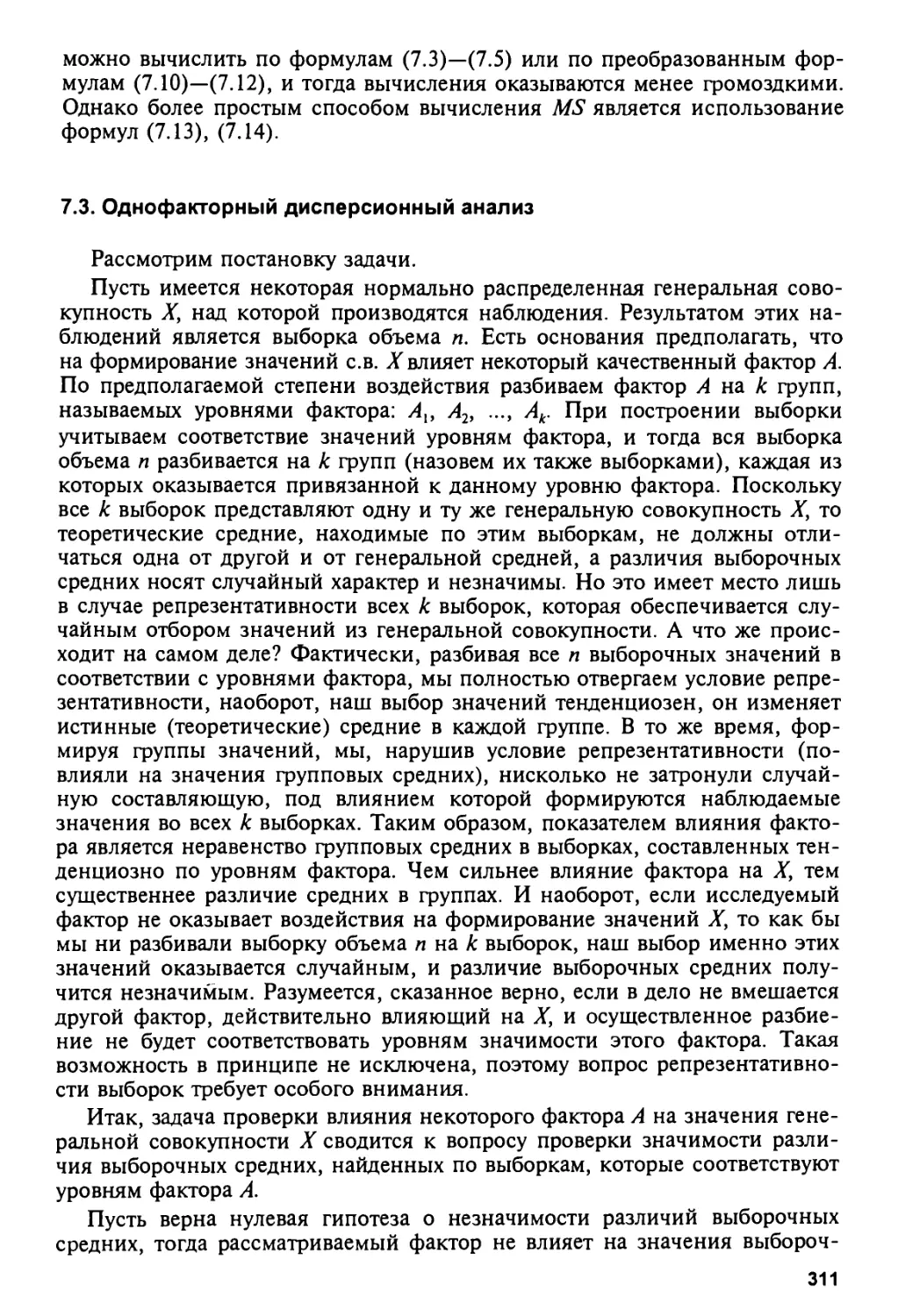

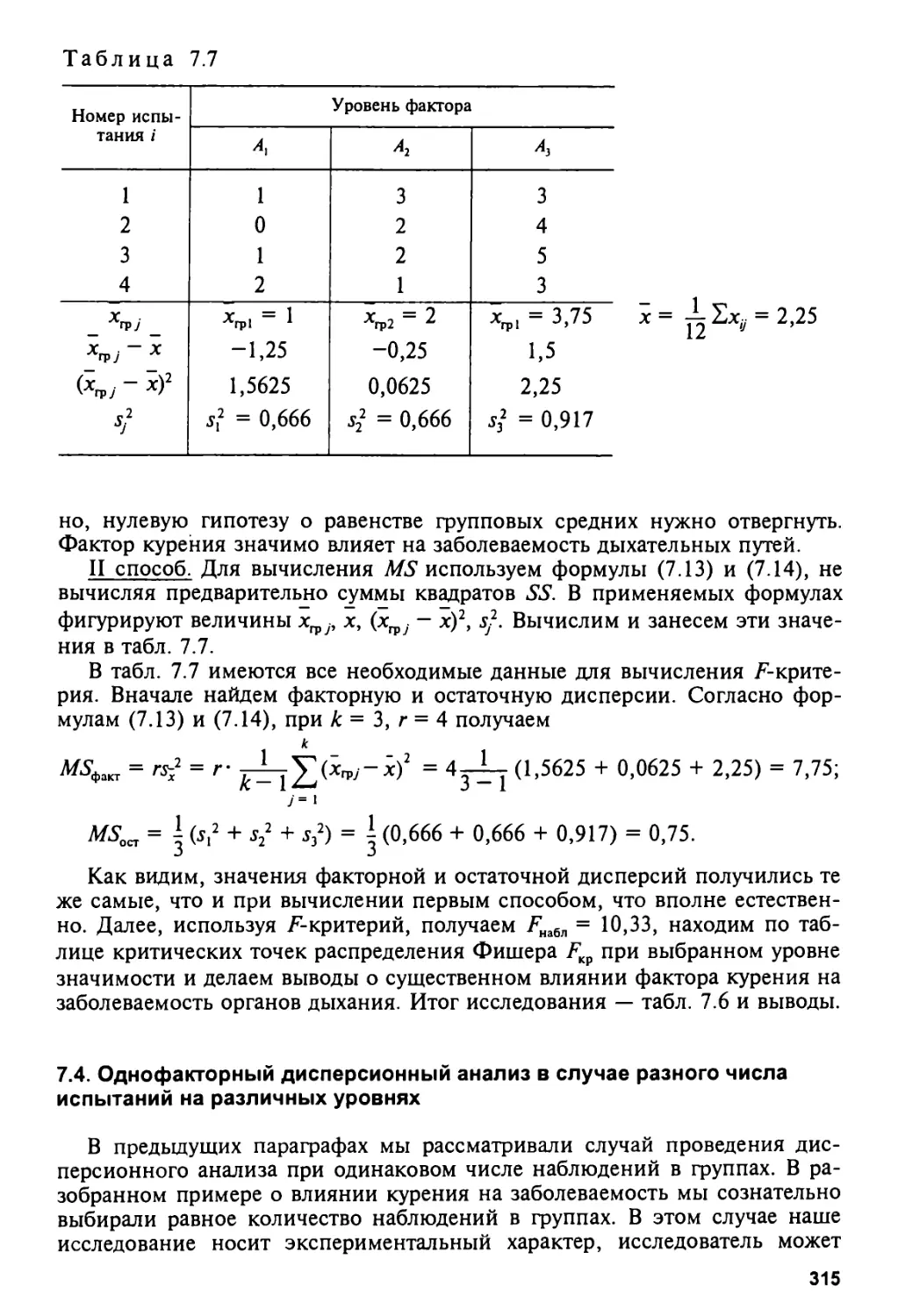

7.3. Однофакторный дисперсионный анализ 311

7.4. Однофакторный дисперсионный анализ

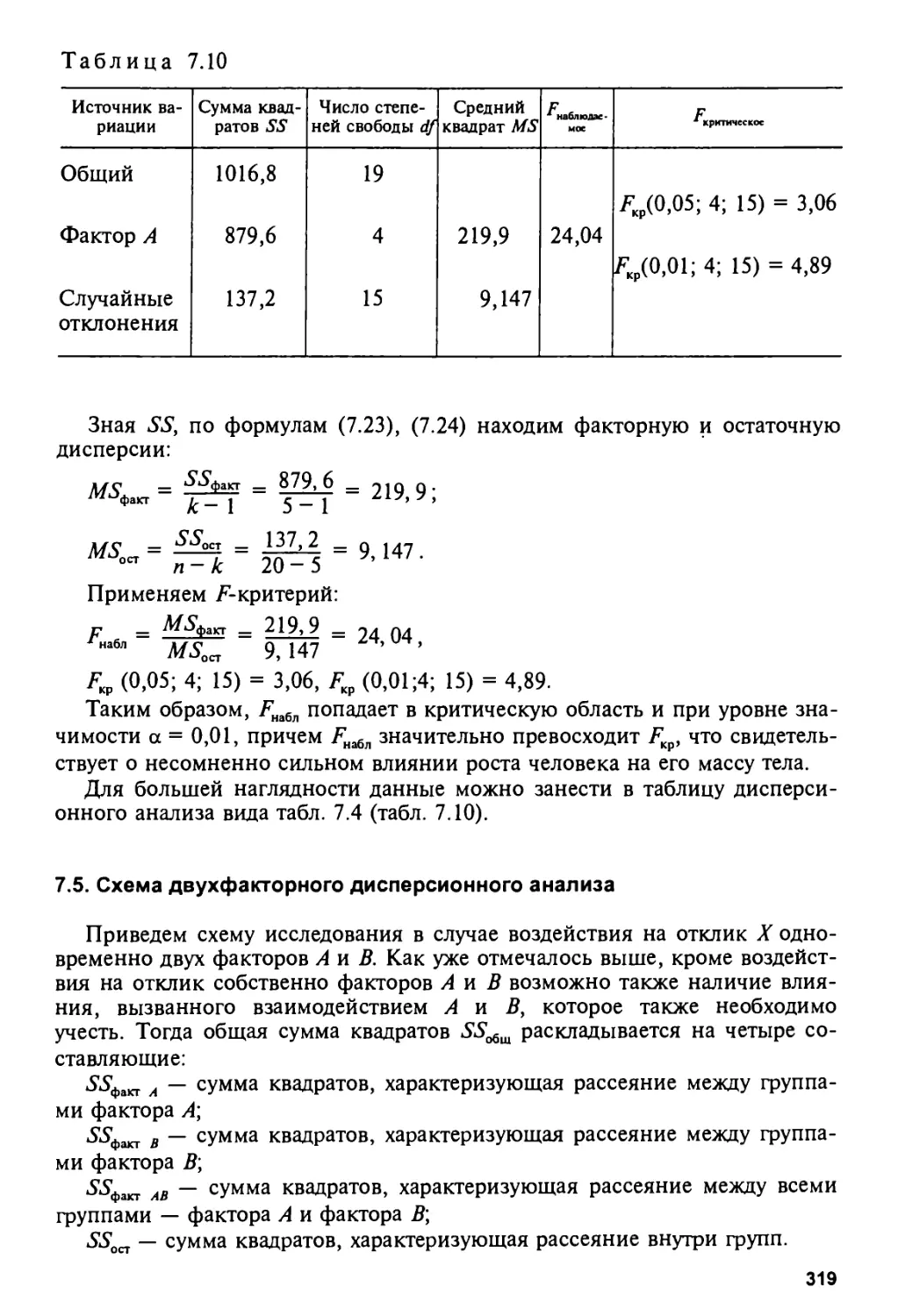

в случае разного числа испытаний на различных уровнях 315

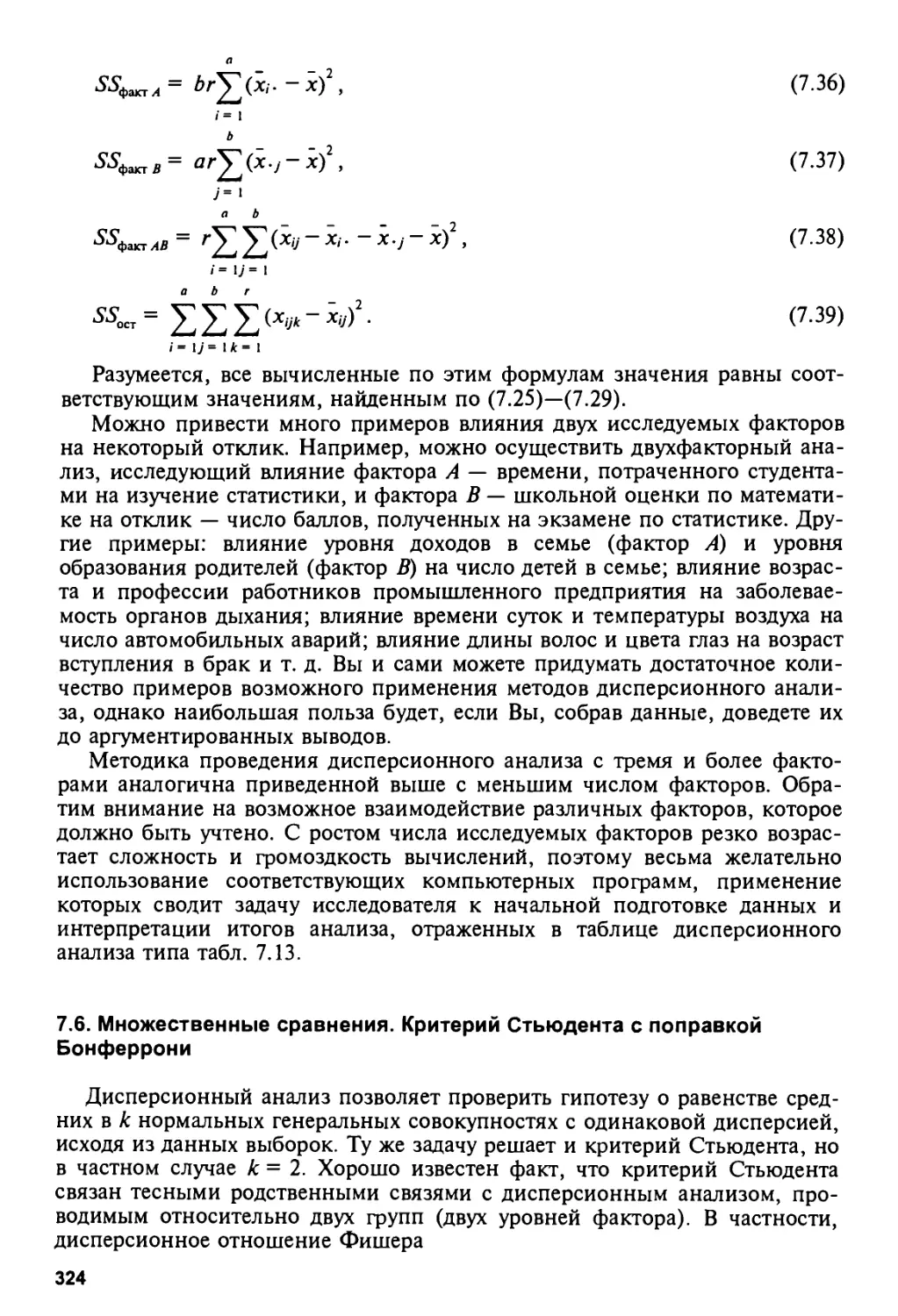

7.5. Схема двухфакторного дисперсионного анализа 319

7.6. Множественные сравнения.

Критерий Стьюдента с поправкой Бонферрони 324

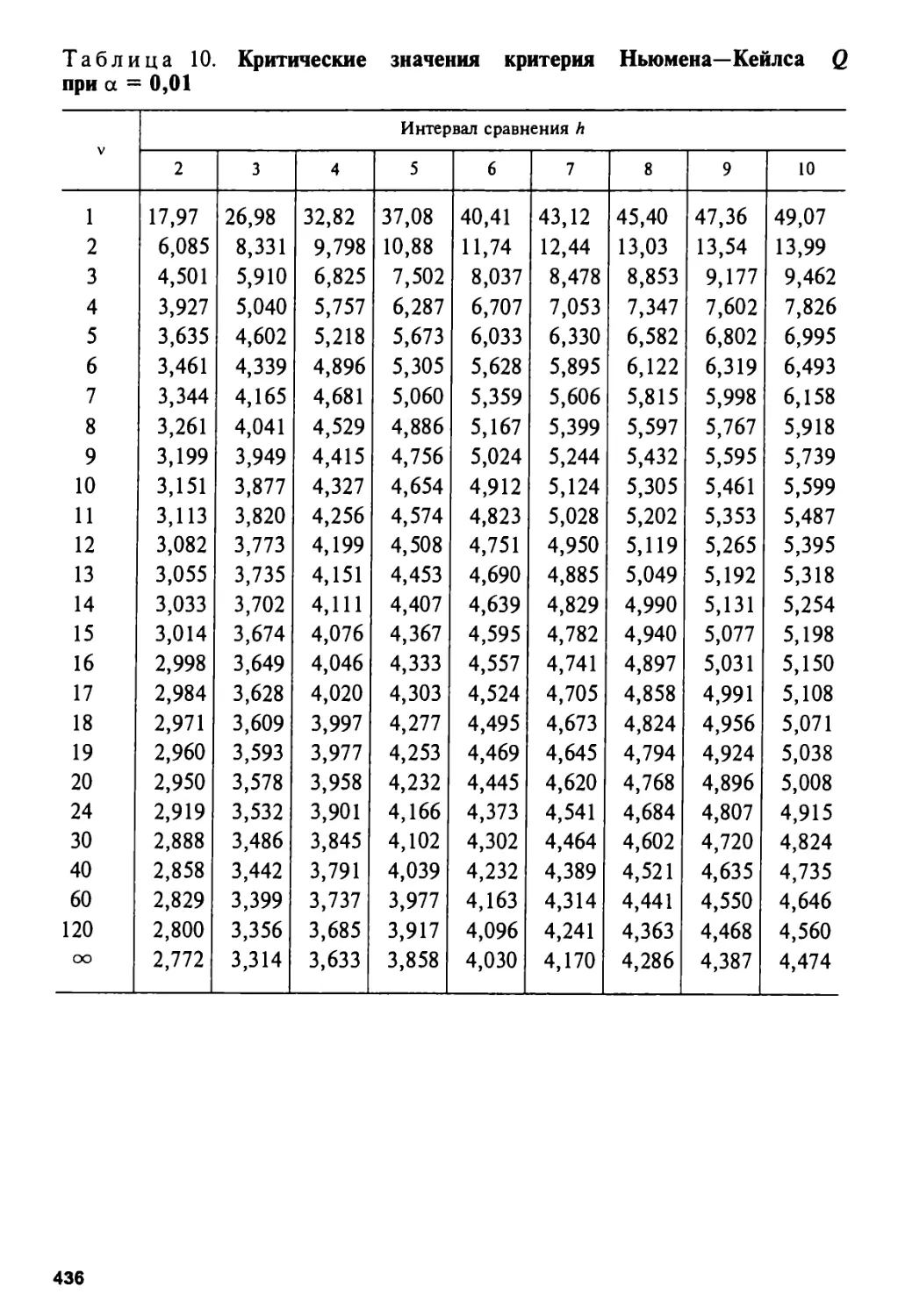

7.7. Критерий Ньюмена—Кейлса 328

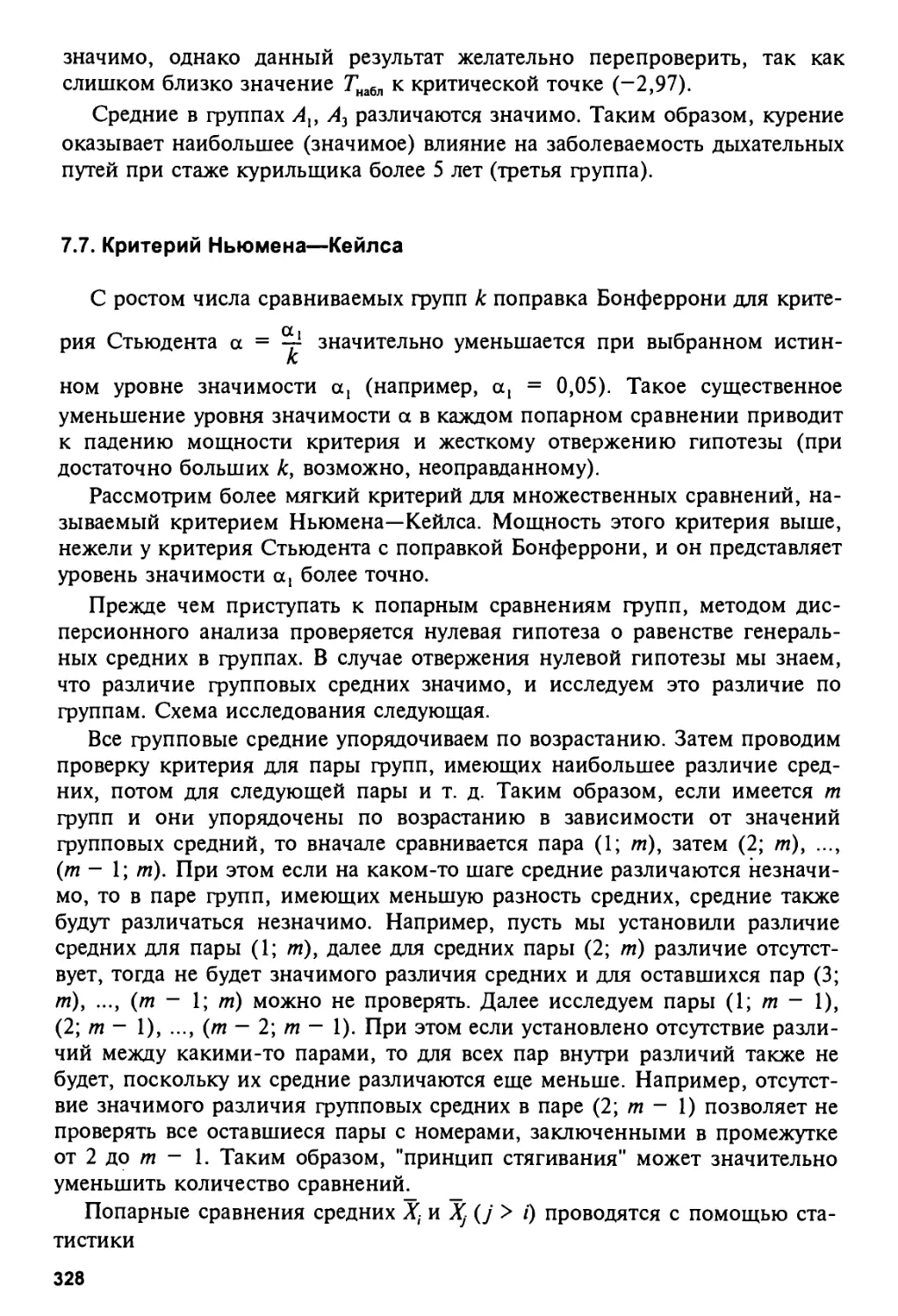

Задачи и упражнения 330

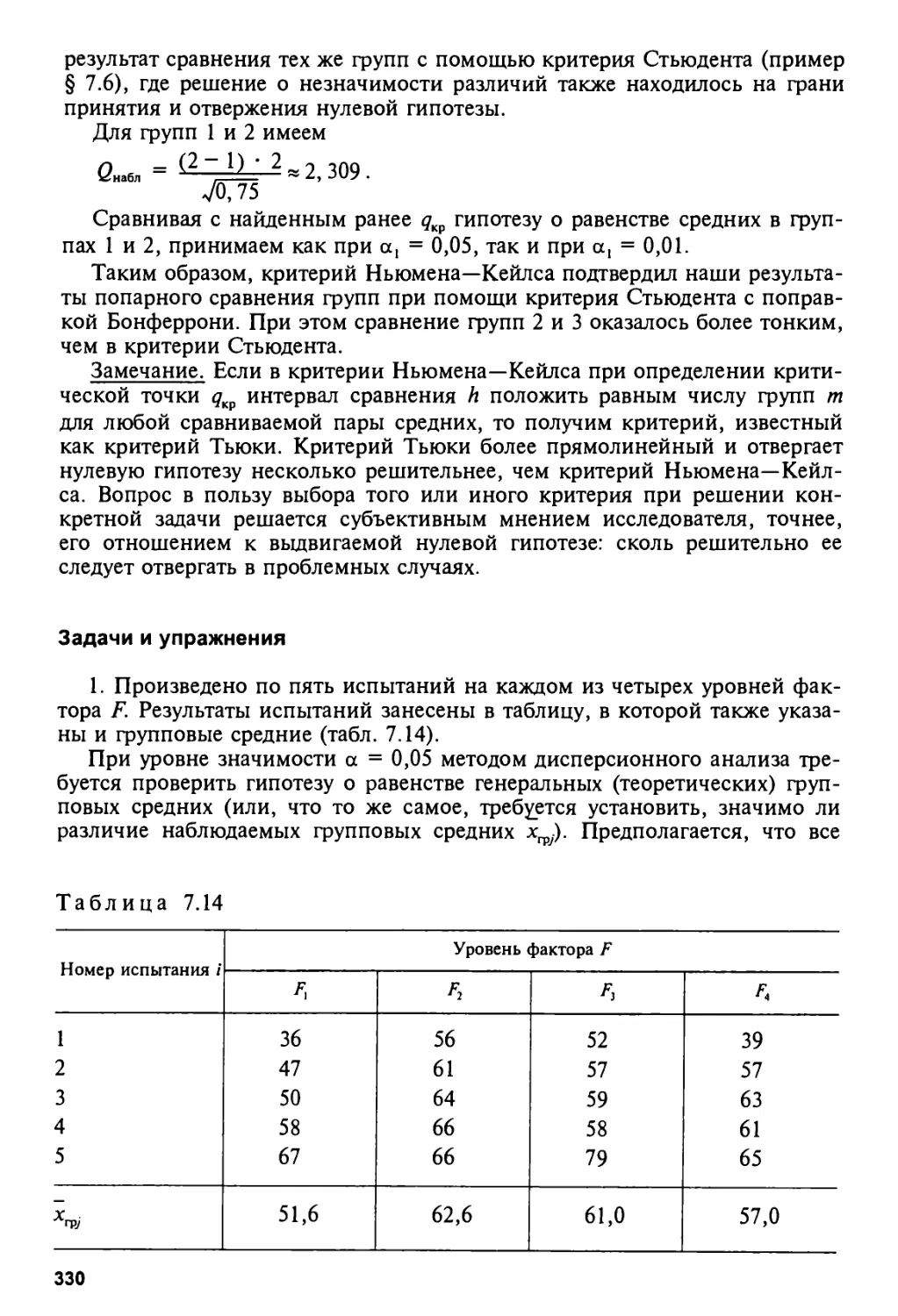

Глава VIII. АНАЛИЗ ЗАВИСИМОСТЕЙ 338

8.1. Типы зависимостей случайных величин 338

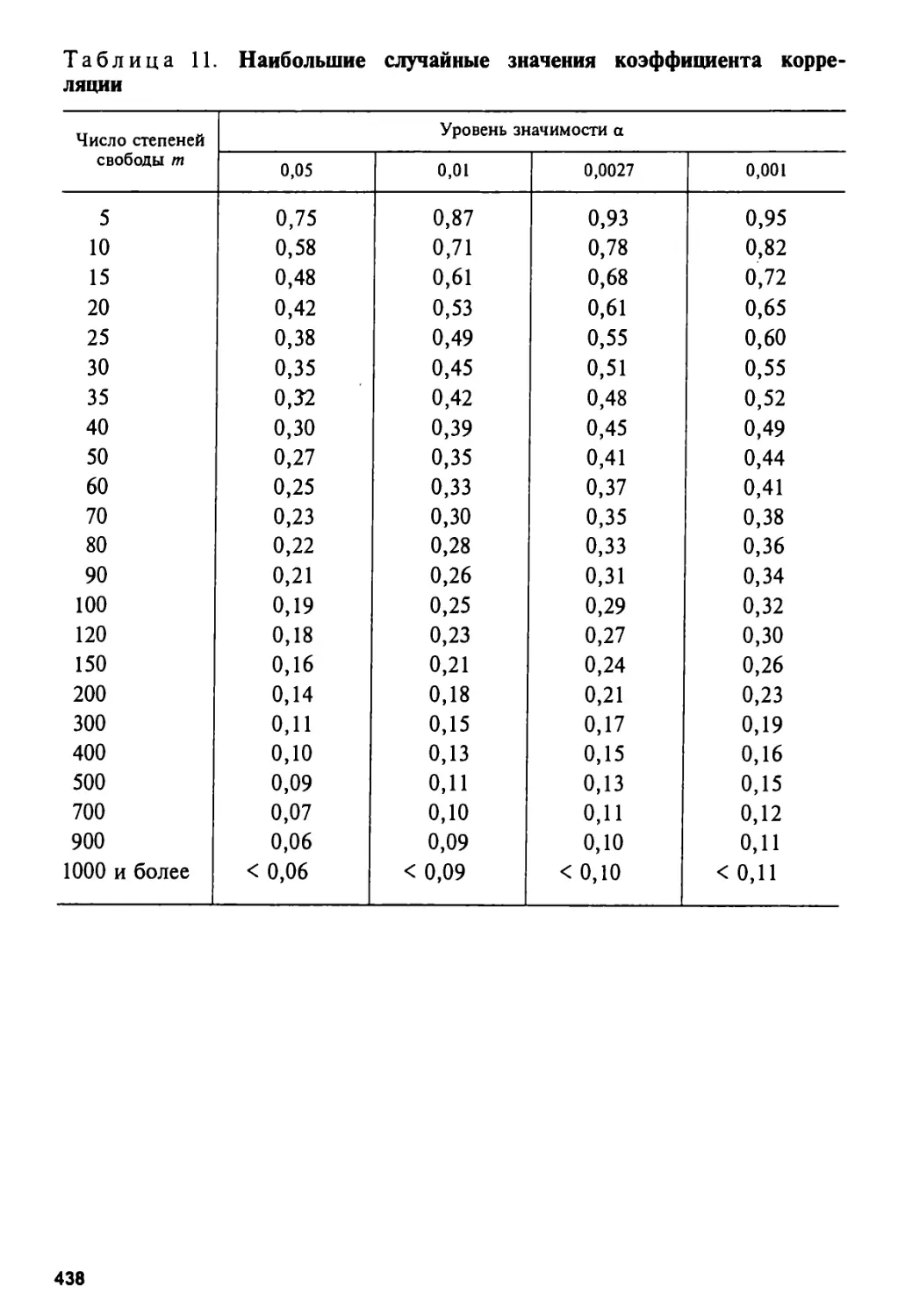

8.2. Выборочный коэффициент корреляции 341

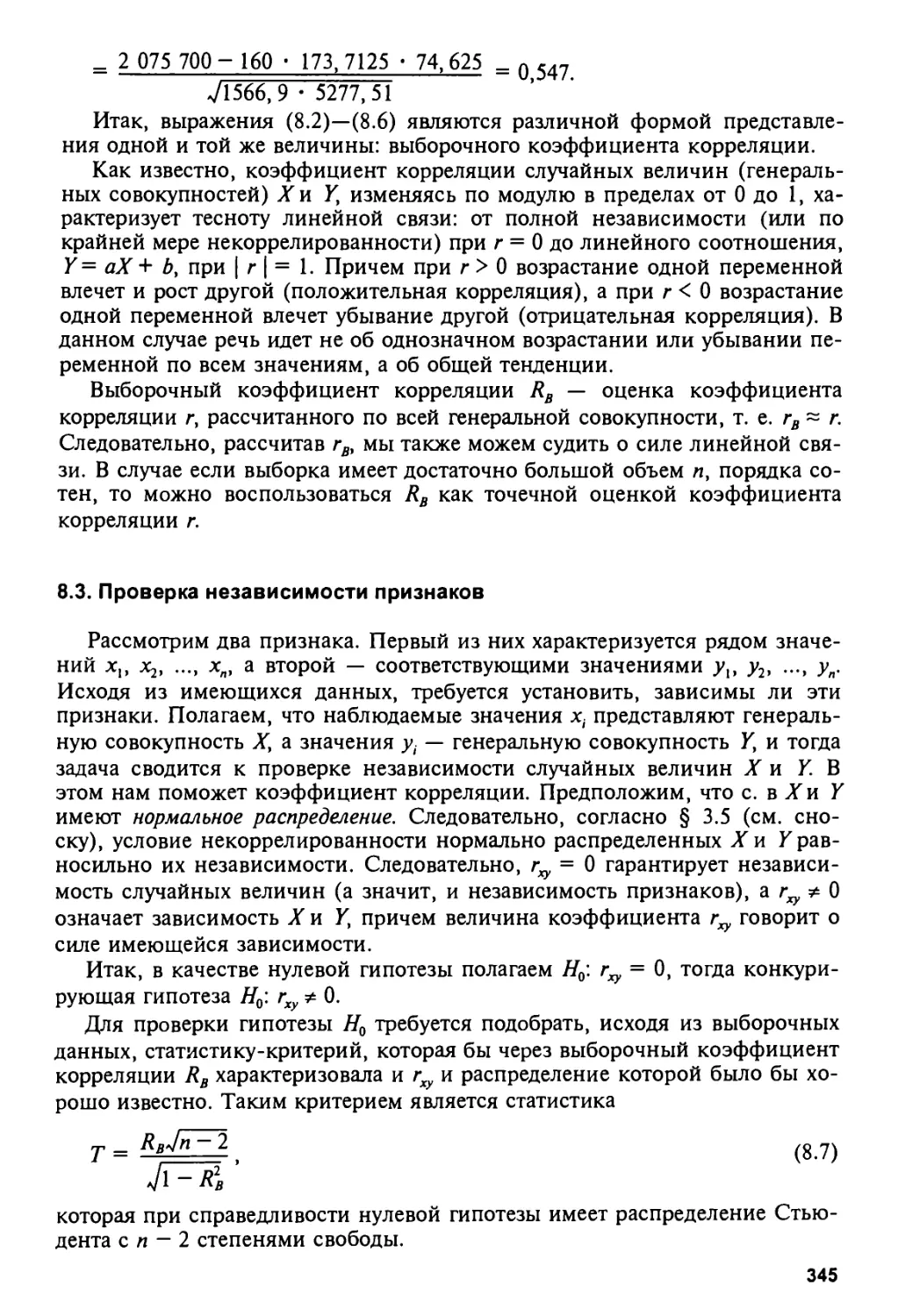

8.3. Проверка независимости признаков 345

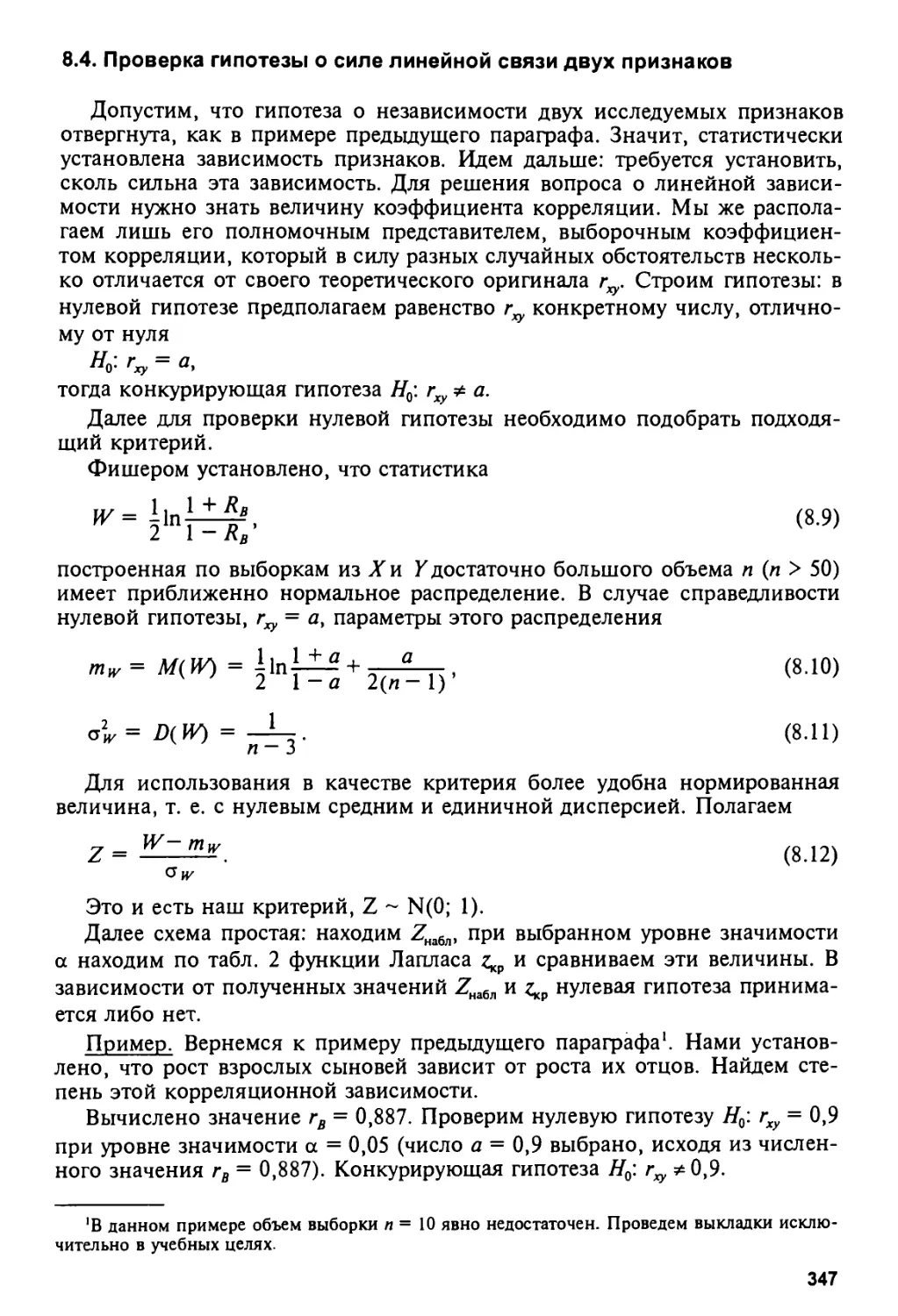

8.4. Проверка гипотезы о силе линейной связи двух признаков 347

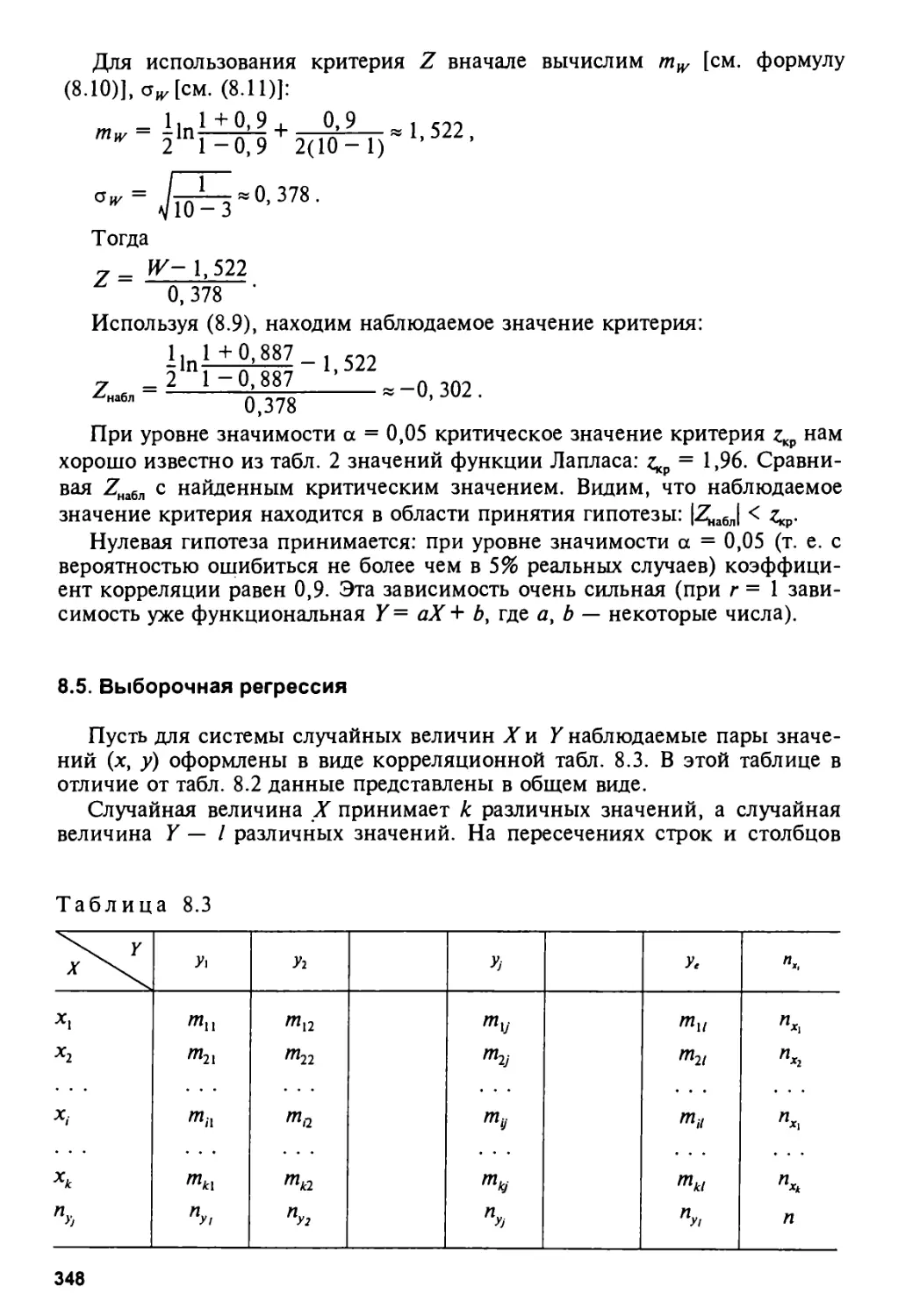

8.5. Выборочная регрессия 348

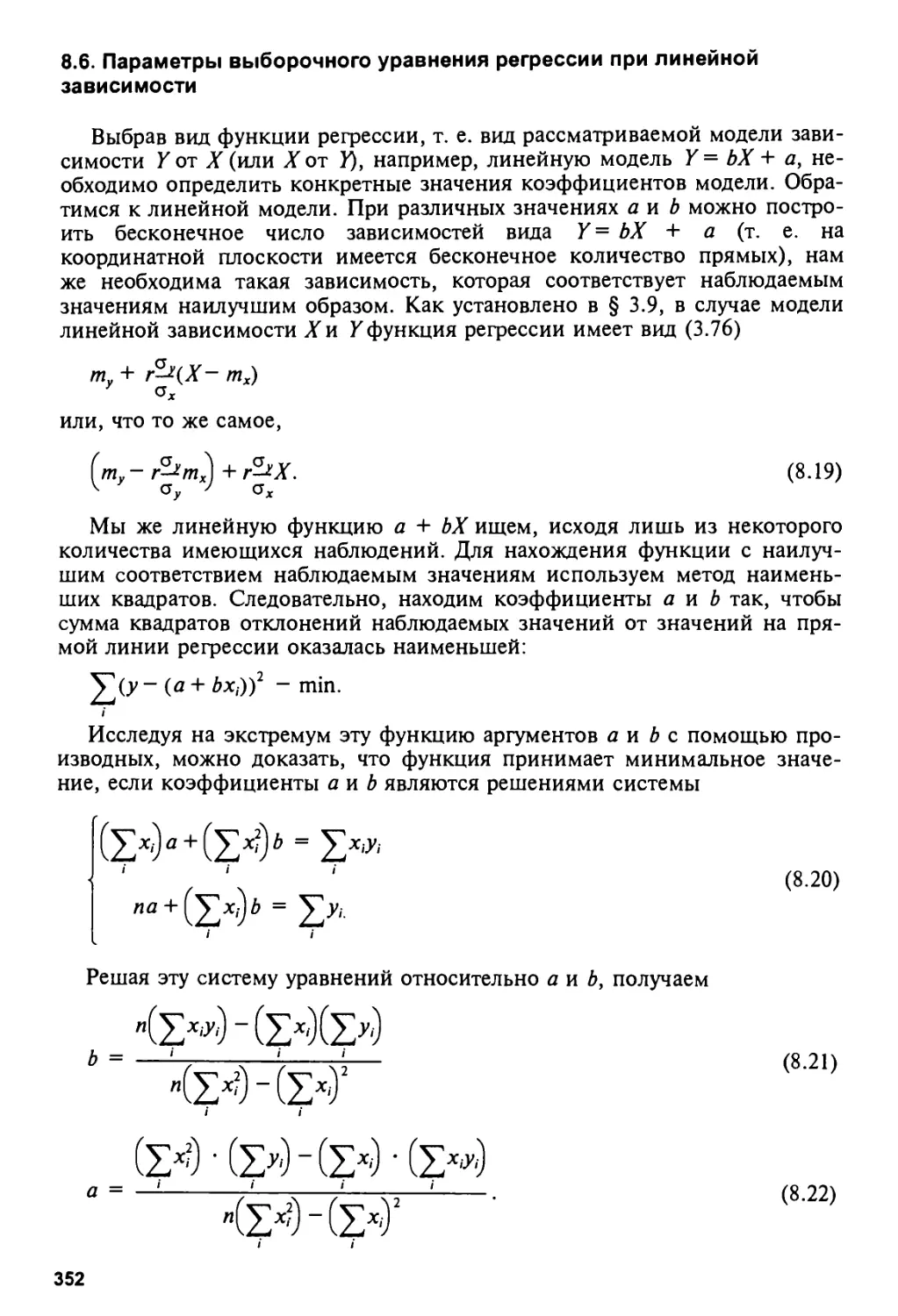

8.6. Параметры выборочного уравнения регрессии при линейной зависимости 352

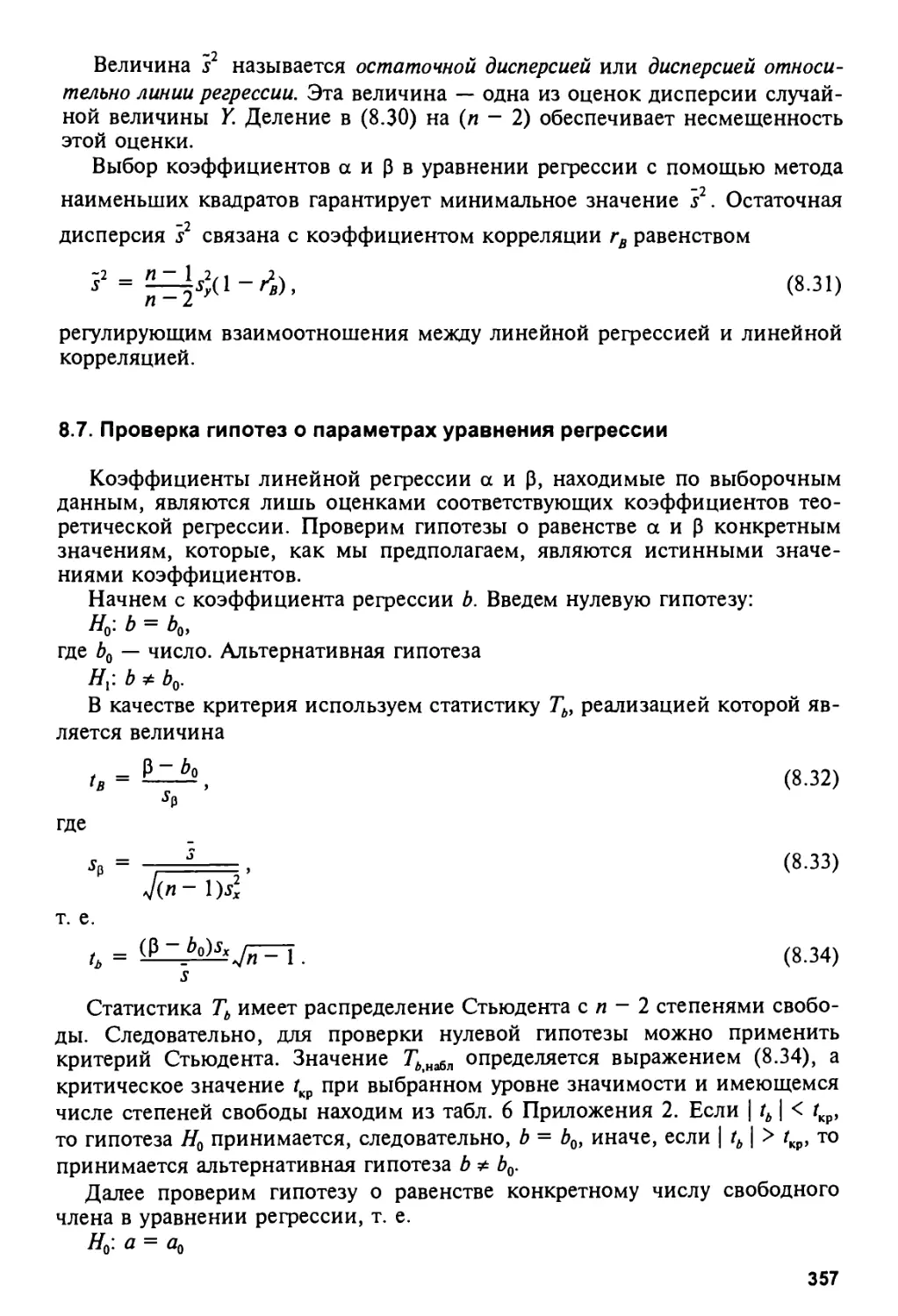

8.7. Проверка гипотез о параметрах уравнения регрессии 357

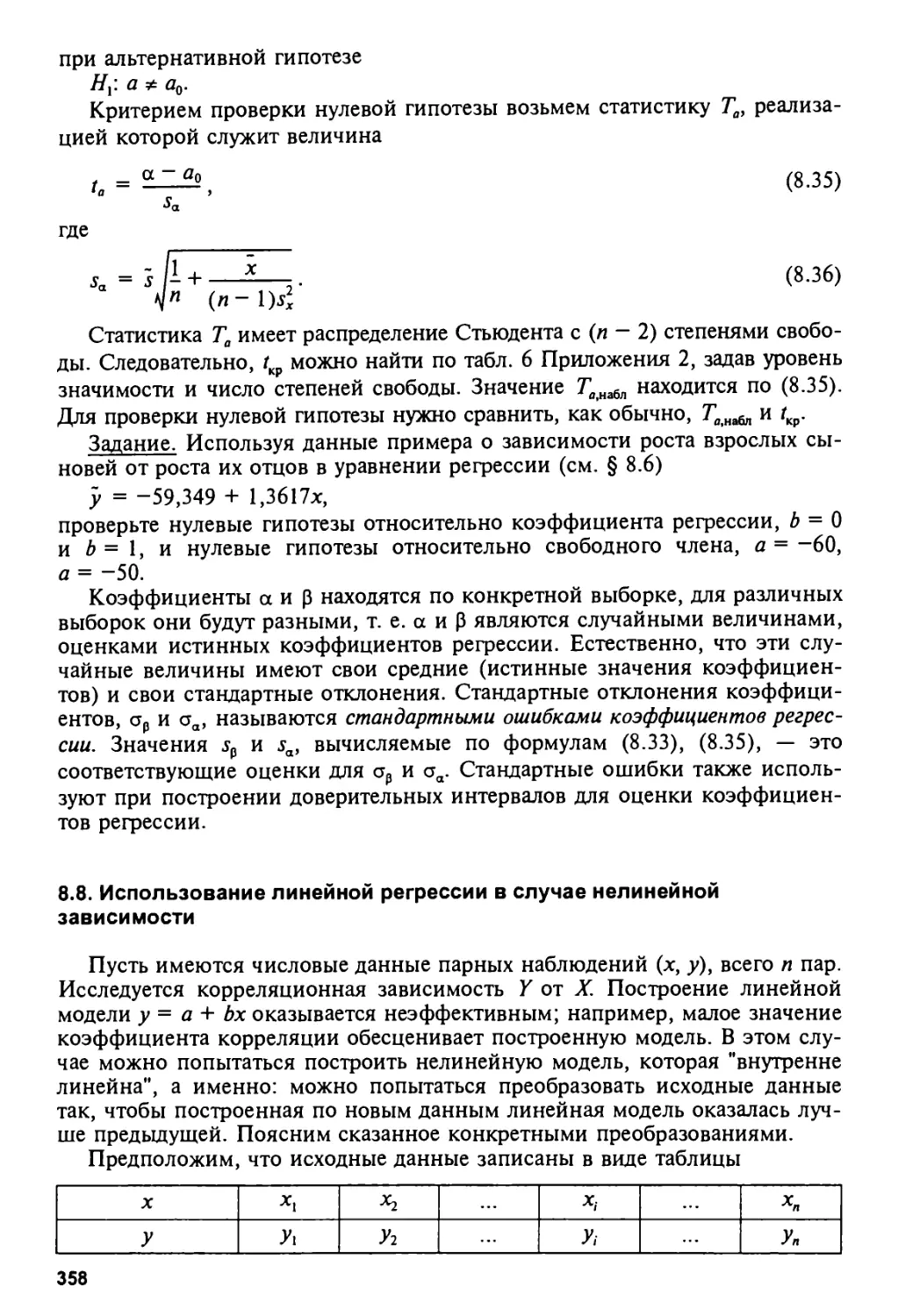

8.8. Использование линейной регрессии в случае нелинейной зависимости. . 358

8.9. Мера любой корреляционной связи.

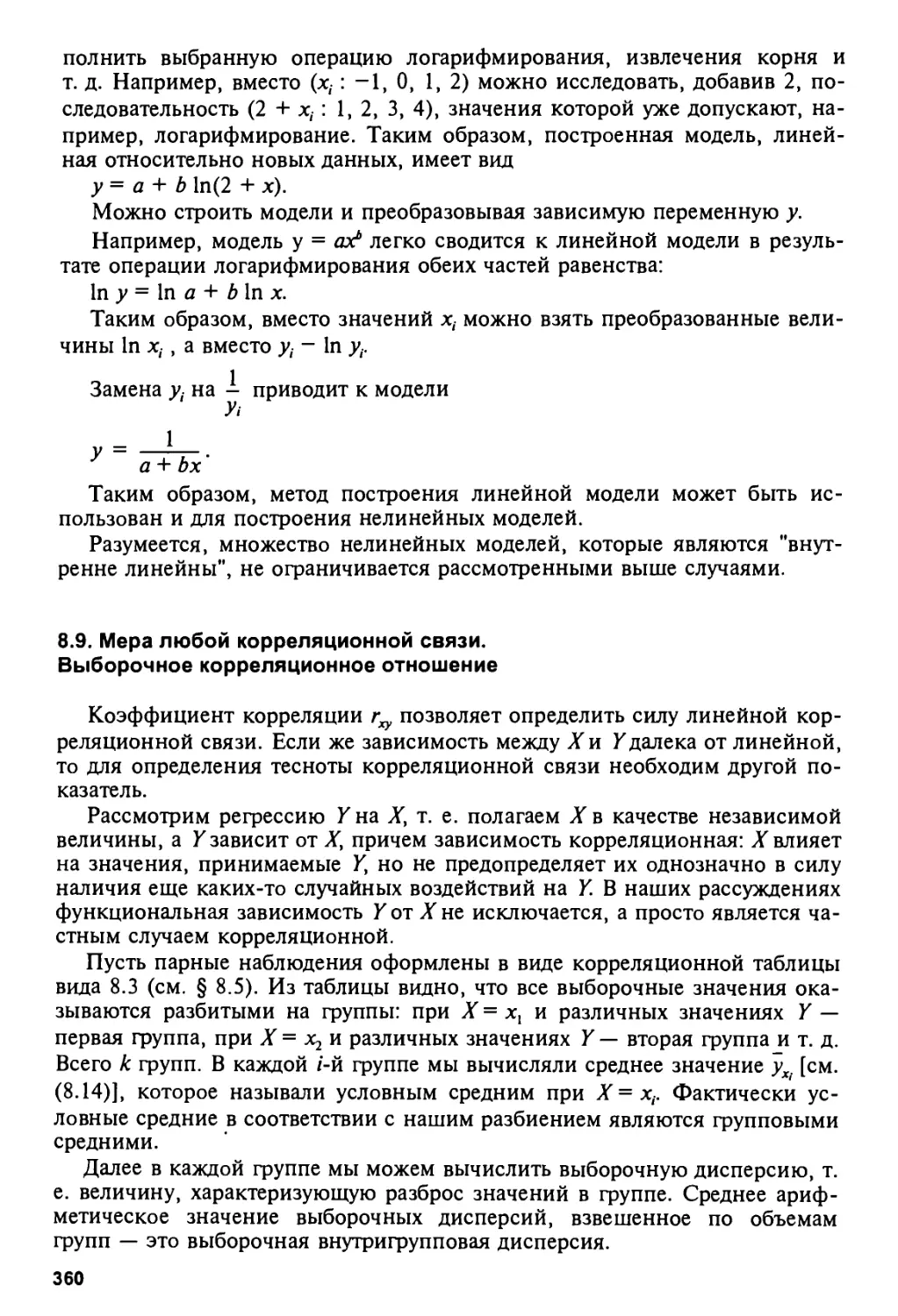

Выборочное корреляционное отношение 360

8.10. Простейшие случаи нелинейной регрессии 363

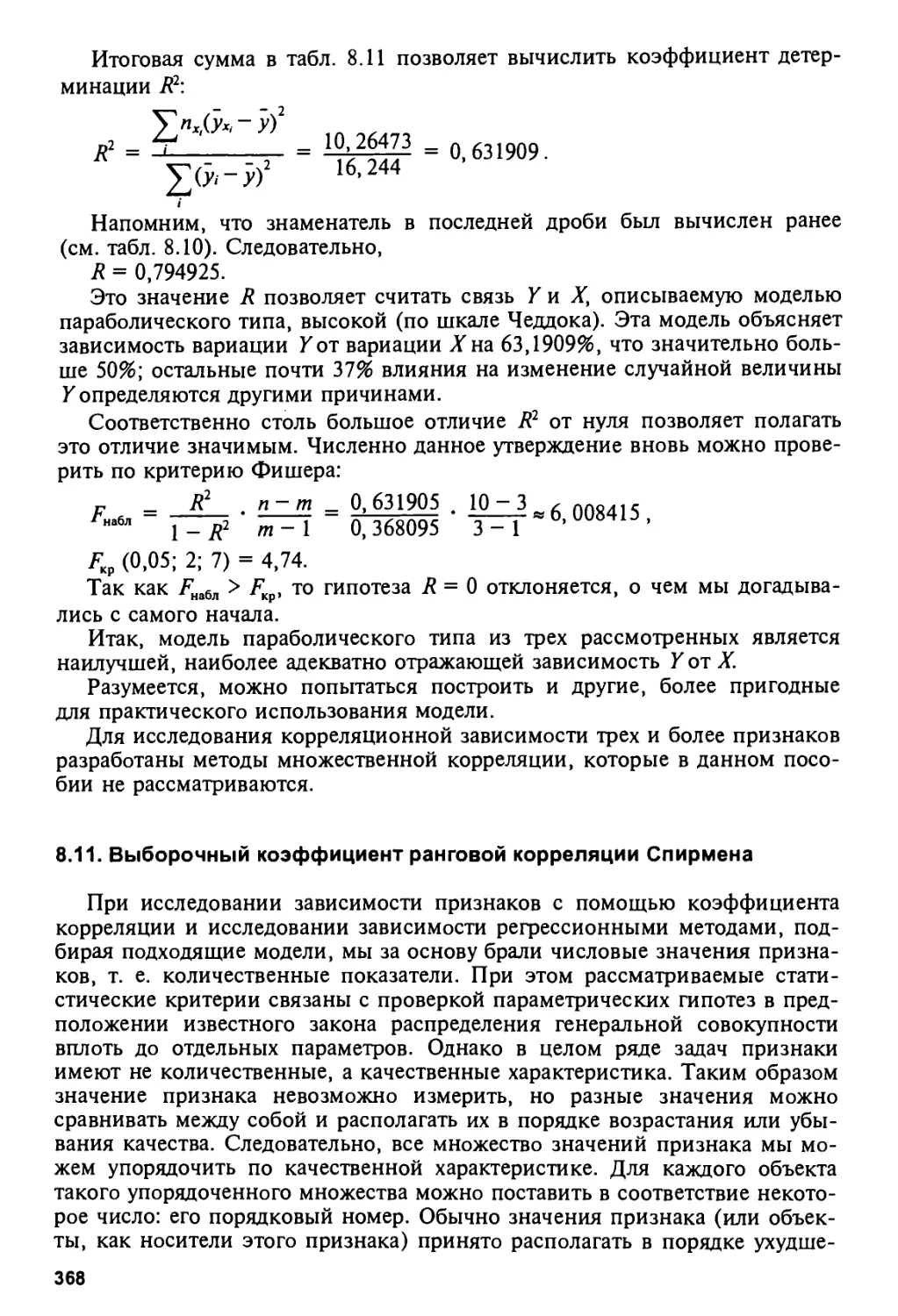

8.11. Выборочный коэффициент ранговой корреляции Спирмена 368

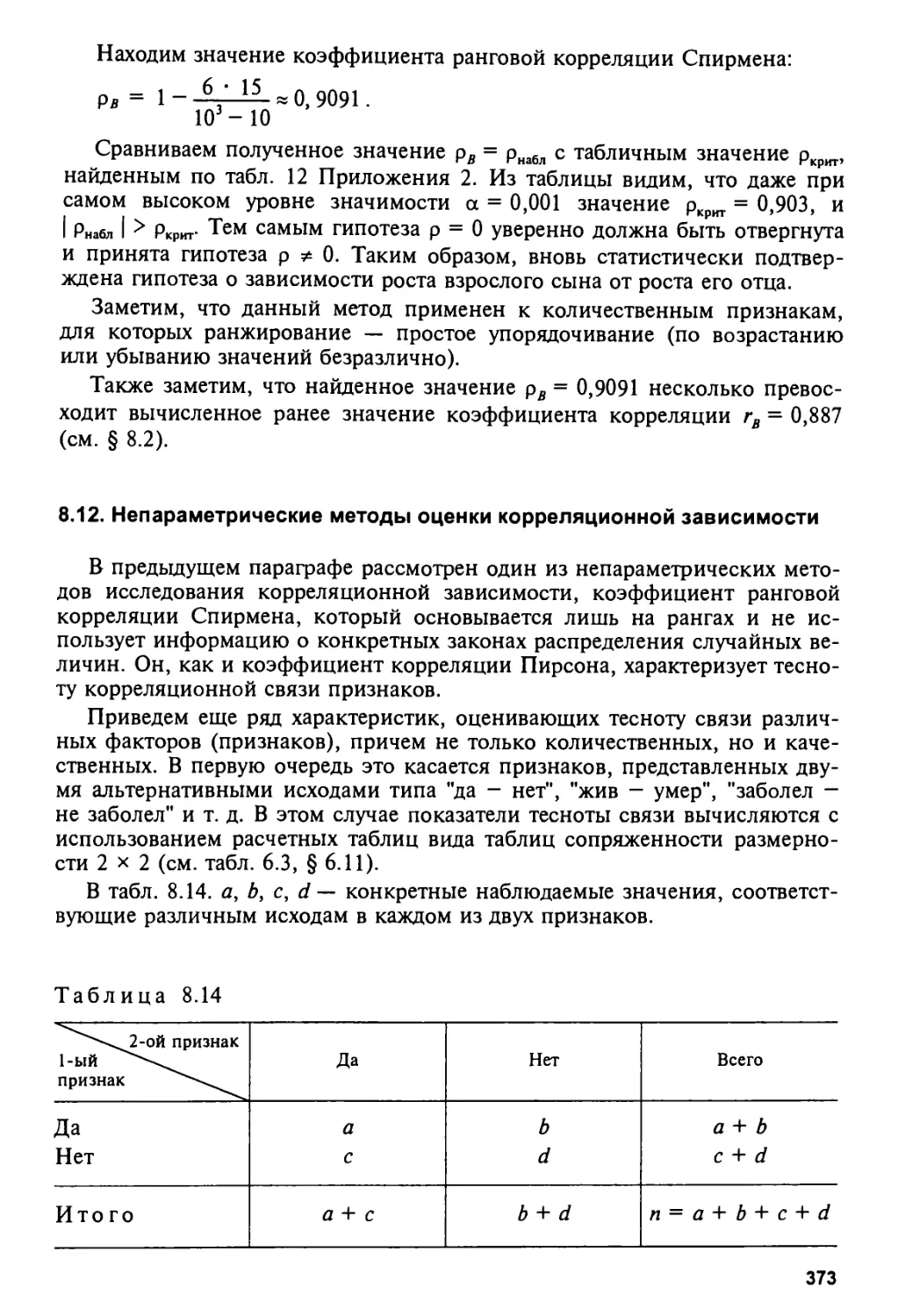

8.12. Непараметрические методы оценки корреляционной зависимости . . . . 373

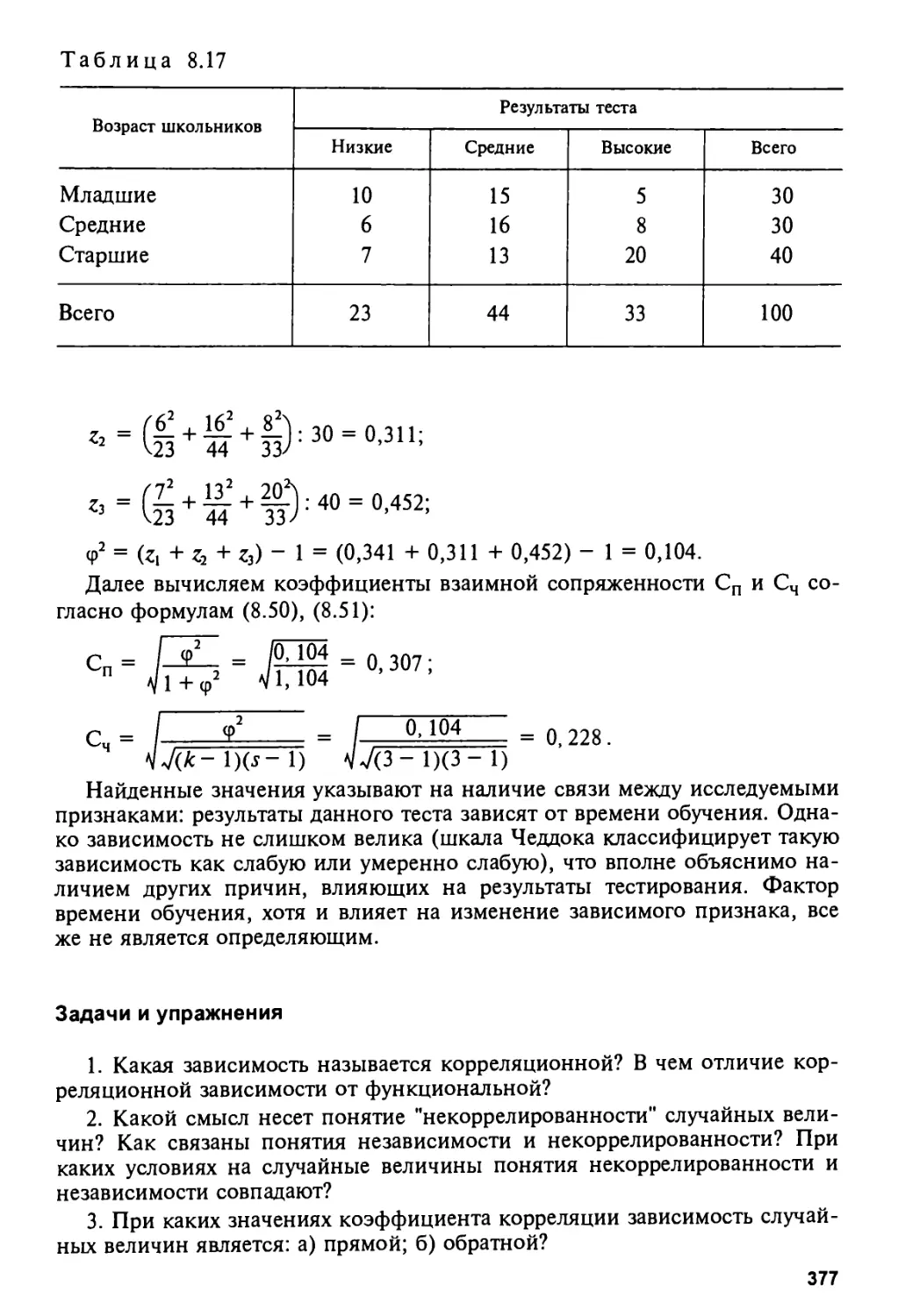

Задачи и упражнения 377

6

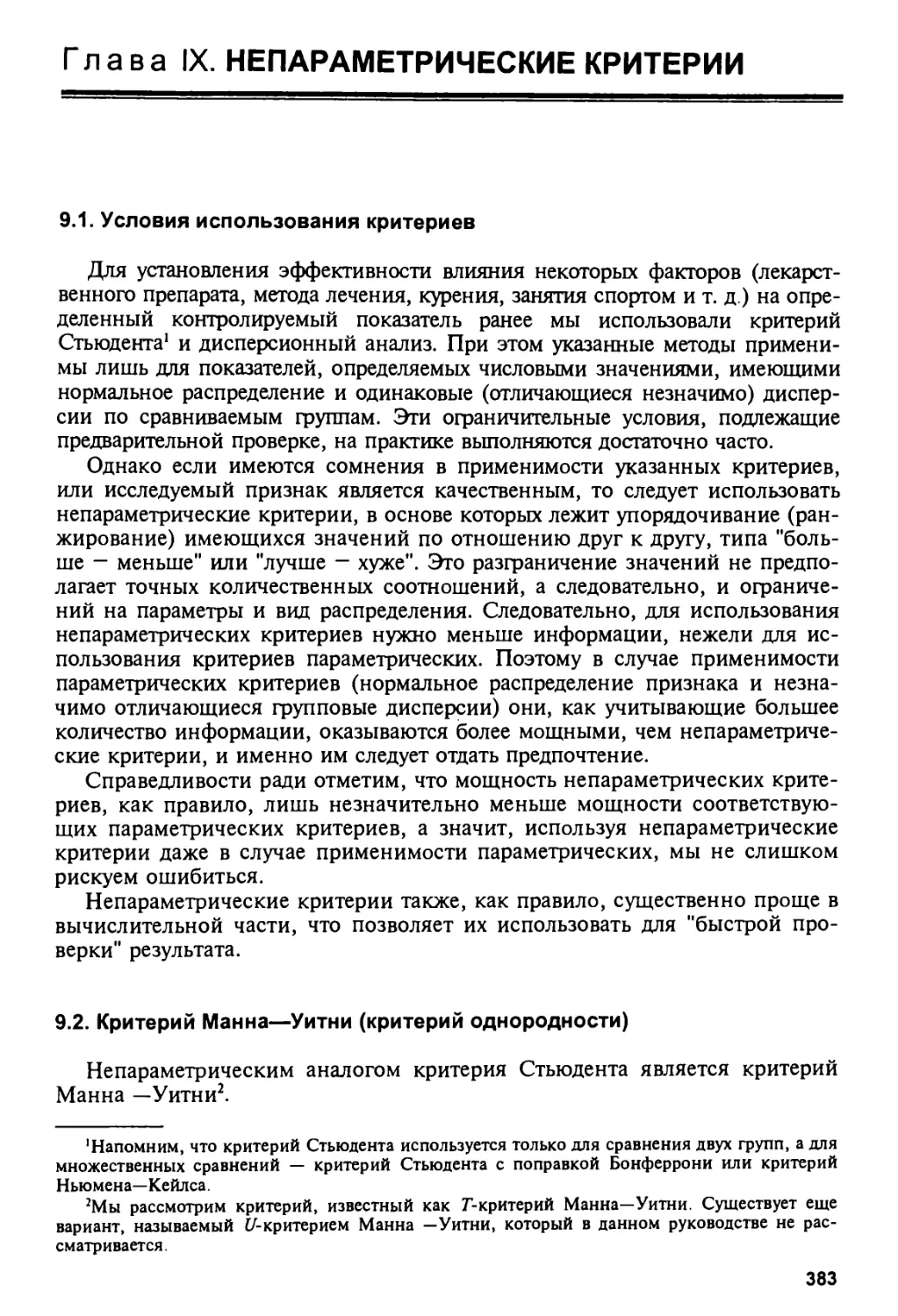

Глава IX. НЕПАРАМЕТРИЧЕСКИЕ КРИТЕРИИ 383

9.1. Условия использования критериев 383

9.2. Критерий Манна—Уитни (критерий однородности) 383

9.3. Критерий Уилкоксона (наблюдения до и после эксперимента) 391

9.4. Критерий Краскела—Уоллиса

(проверка однородности нескольких групп) 397

Задачи и упражнения 400

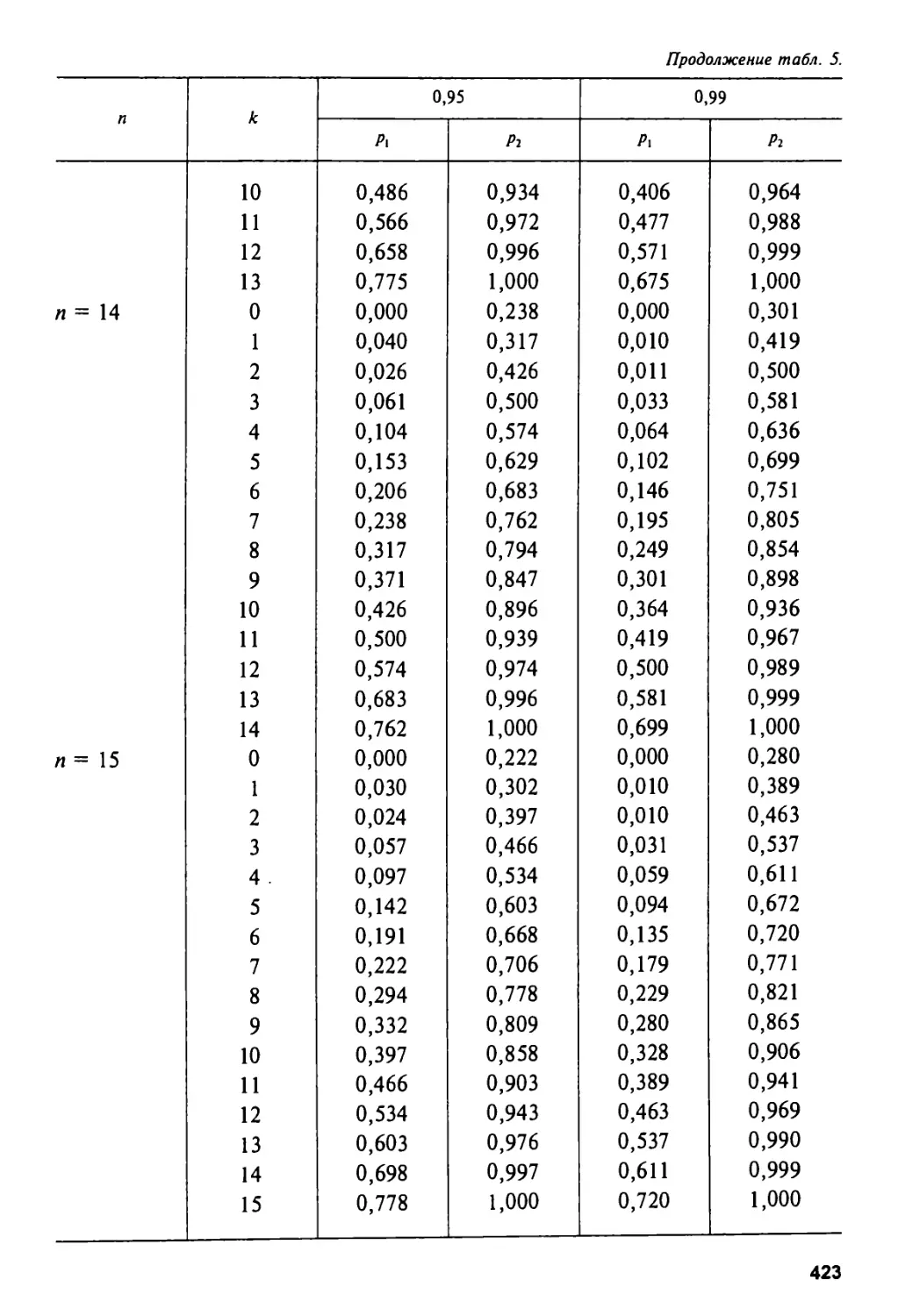

Приложение 1 404

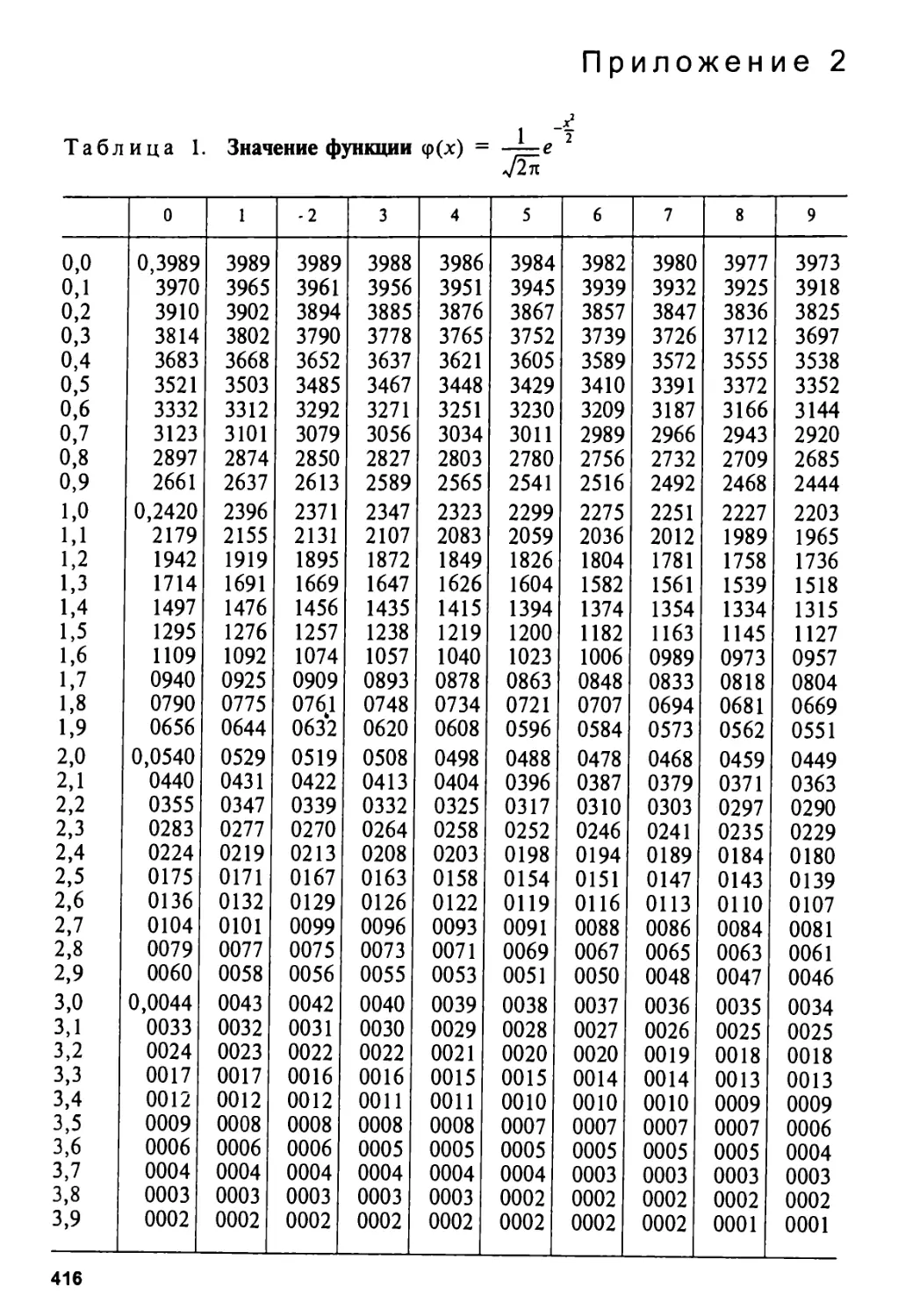

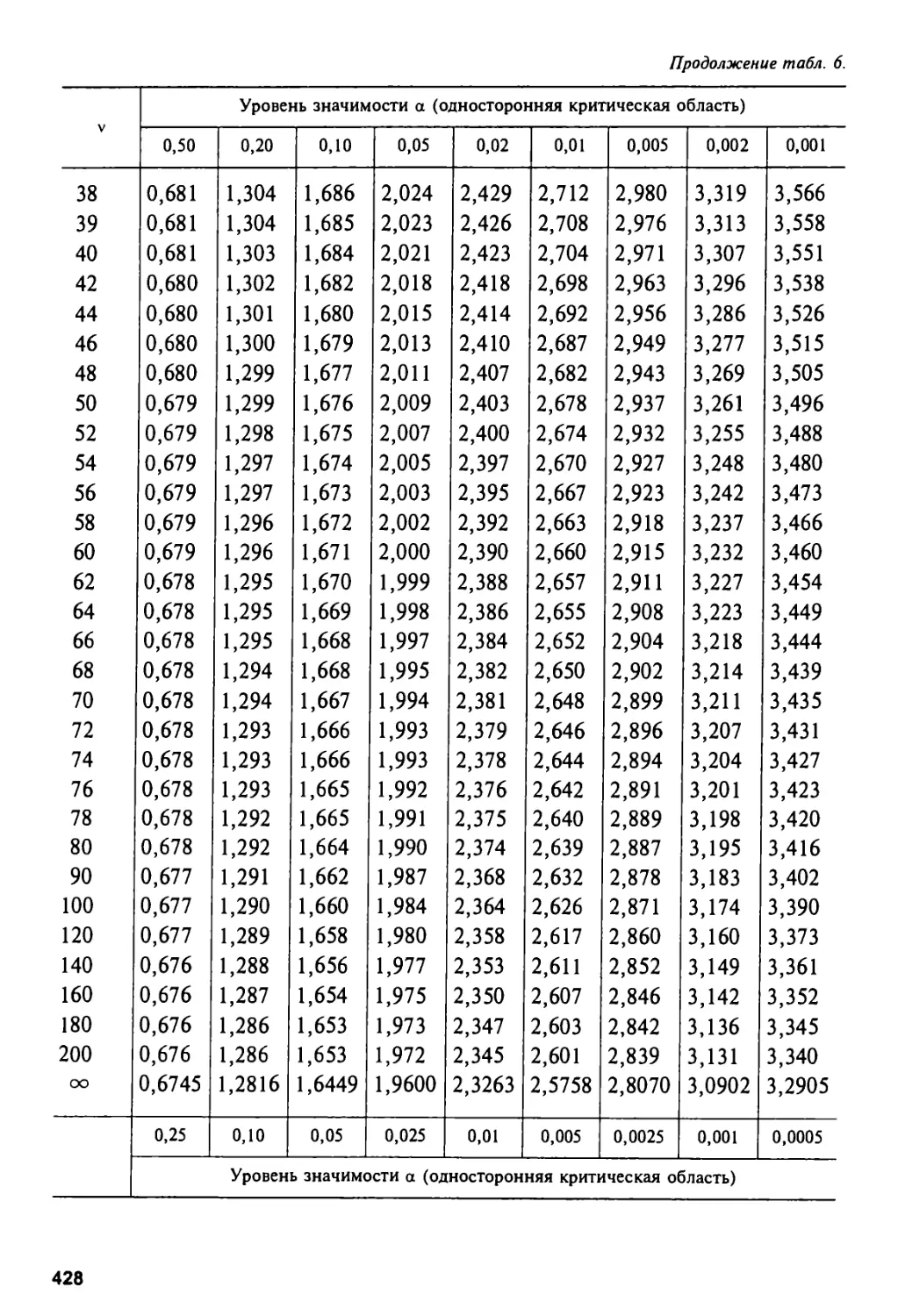

Приложение 2 416

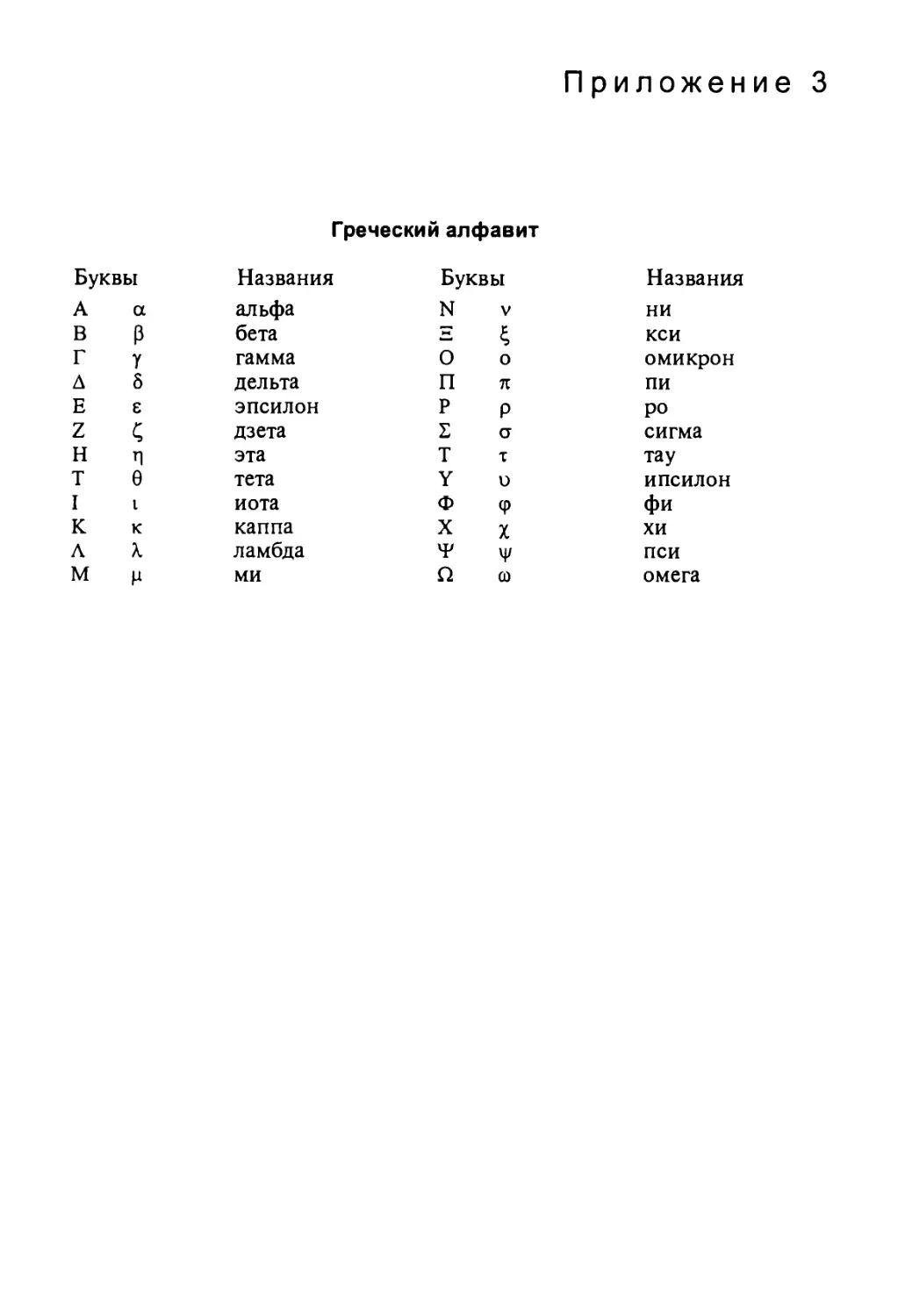

Приложение 3 450

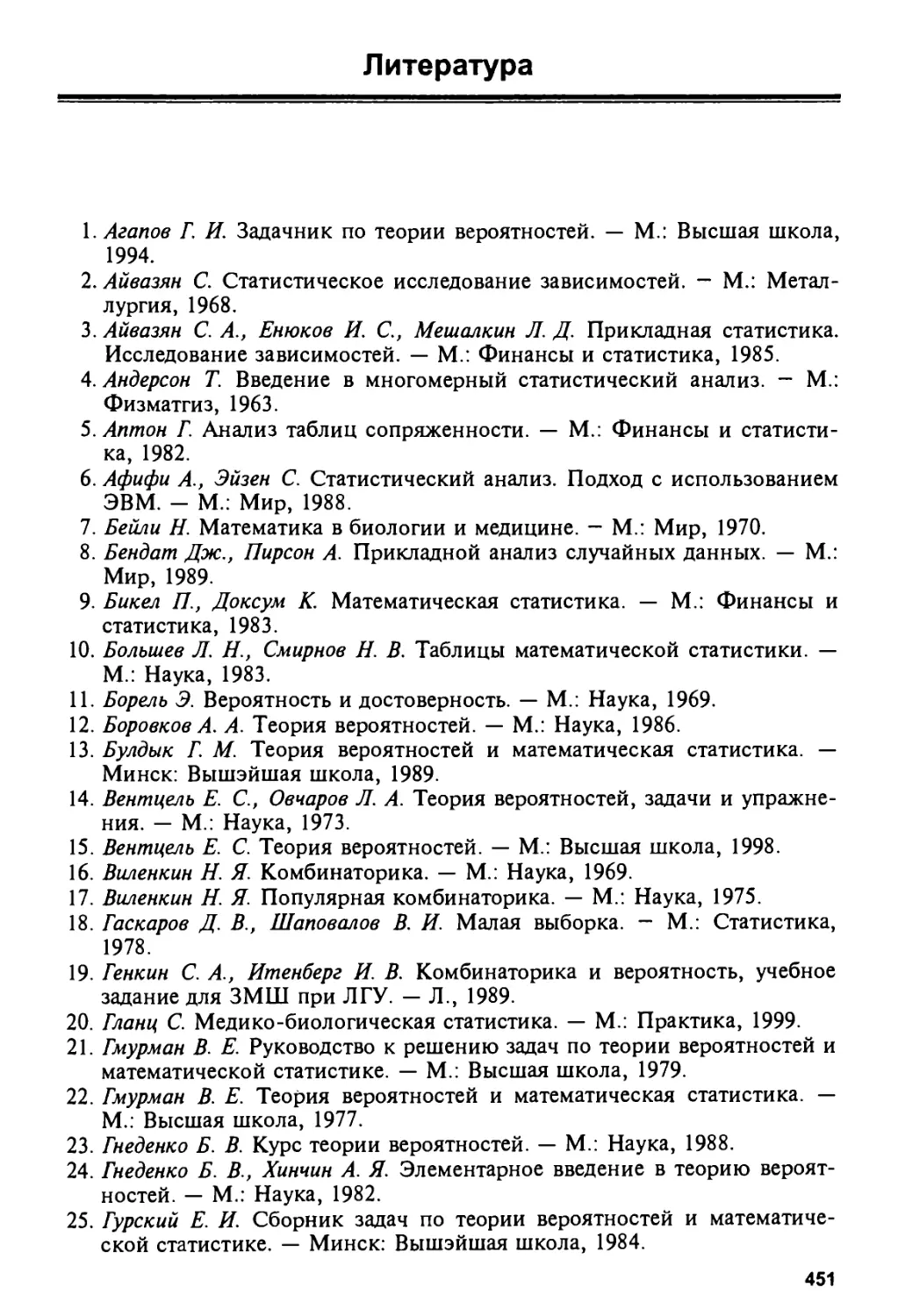

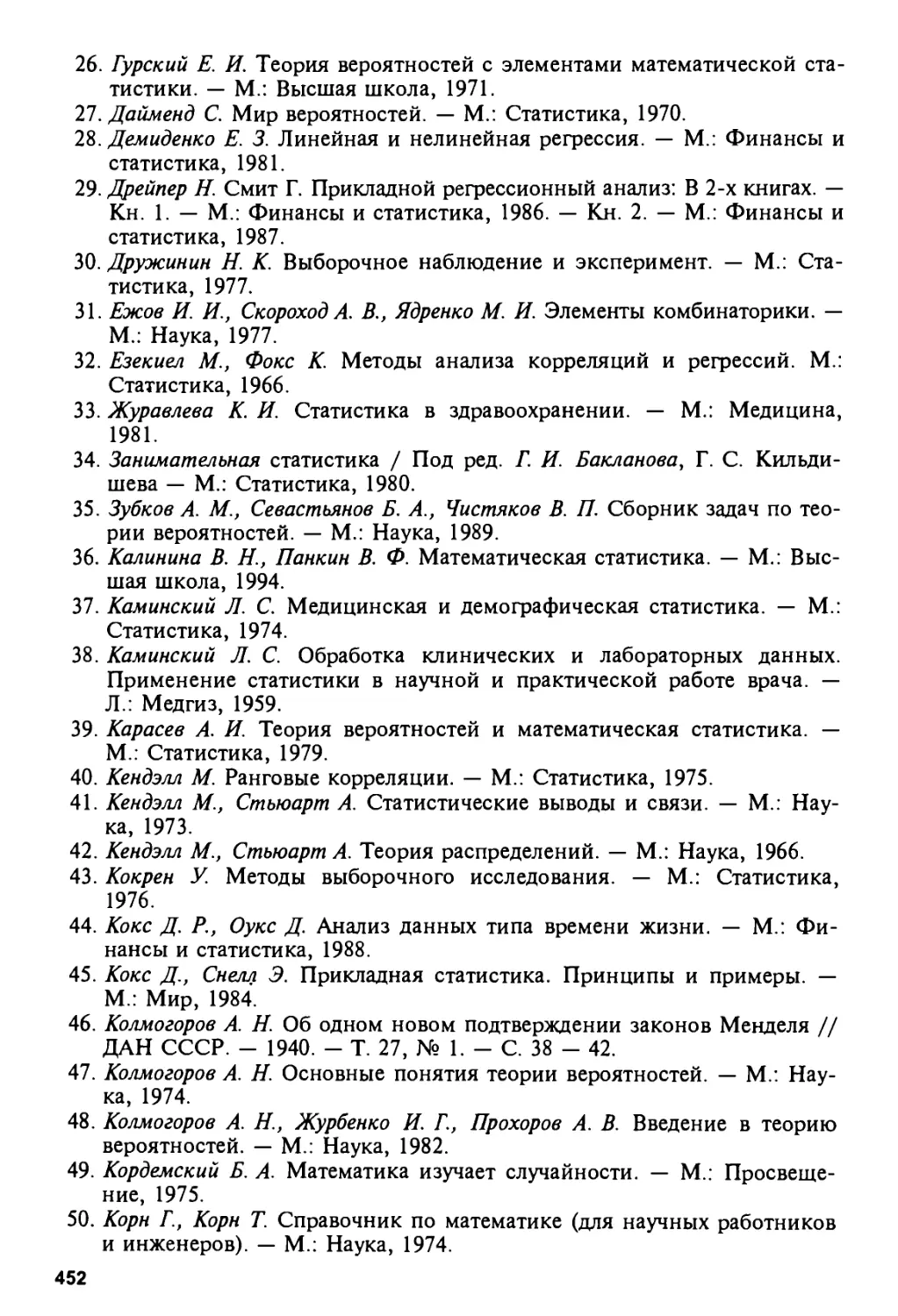

Литература 451

... не проникнуться

воинственностью и мужеством на поле боя от

одной хорошей речи, так же как нельзя

стать музыкантом, прослушав одну

хорошую песню. Этим можно

овладеть только после длительного и

основательного обучения."

Мишель Монтень

Предисловие

Уважаемый читатель!

Вы берете в руки эту новую книгу и, конечно же, начинаете ее

просматривать с оглавления, и сразу же бросается в глаза, что в одном руководстве

фактически объединены три книги, которые могут носить вполне

самостоятельный характер, первые две из которых посвящены математическим

аспектам статистики (теоретической и практической), а третья

(прикладная) — статистике здоровья и здравоохранения.

Ранее на эти темы для медицинских работников существовали

фундаментальные руководства, выпущенные как в России (Козлов, Медков,

Поляков, Шиган и др.), так и за рубежом с переводом на русский язык

(Сепетлиев, Фишер, Бейли и др.). К сожалению, эти руководства в

настоящее время стали раритетами и, естественно, не очень доступными

современному читателю. С другой стороны, за последние годы в

статистике произошел целый ряд коренных изменений, связанных прежде

всего с использованием современных компьютеров и адекватного

программного обеспечения. Если раньше достаточно было, исходя из

обработки данных пробного исследования, рассчитать основные параметры

вариационного ряда и с учетом необходимой достоверности и

устойчивости результатов можно было определить численность выборки, то в

последние годы наряду с этим традиционным подходом, зародившимся в

недрах Эдинбургской школы, все чаще используются вероятностные

методы и подходы. Если раньше для оценки взаимосвязей и других

отношений между изучаемыми явлениями достаточно было использовать ме-

8

тоды оценки достоверности различий, Г-критерий Стьюдента, хи-квад-

рат, коэффициенты сопряженности Пирсона и Чупрова, метод Спирмена

и т. д., а затем стали применяться более сложные методы и модели

(линейные и многофакторные корреляционный, регрессионный,

дисперсионный анализы и т. д.), то в настоящее время можно использовать

готовый пакет программных средств, значительно облегчающий всю

вычислительную работу. К этому следует добавить необходимость понимания

возможностей каждого метода и разной интерпретации полученных

результатов, ибо очень часто применение методов математической

статистики отражает дань моде, а не целесообразности для данного

конкретного исследования.

Вместе с тем остаются незыблемыми основные постулаты и атрибуты

любого исследования: методы планирования исследования и

эксперимента, случайного, непреднамеренного и многоступенчатого отбора,

правильного выбора объекта и предмета исследования, формирования выборки и

расчета ее численности, определения этапности и уровней проведения

исследования, определения необходимости контрольной группы и ее

численности, оценки достоверности, устойчивости и представительности

полученных результатов и т. д. и т. п.

Как представляется, уровень требовательности к применению

статистических методов в медицине и здравоохранении, несмотря на

возросшие возможности, в последние десятилетия несколько снизился, что

заметно на примере и плановых и даже диссертационных исследований. С

чем это связано? На наш взгляд, с тем, что традиционно существовавшие

в нашей стране медико-статистические школы, локализованные главным

образом в Москве и Санкт-Петербурге, со сменой поколений постепенно

утрачивали свои позиции, и в наши дни осталось считанное число

носителей этих идей. Конечно же, все это не могло не сказаться на качестве

преподавания статистики в медицинских вузах и средних учебных

заведениях, на формировании мировоззрения у молодых ученых и

специалистов. И если в клинике, гигиене, социальной гигиене эти методы еще

применяются, то в работах по организации здравоохранения они

становятся редкостью.

Таким образом, вопрос о преемственности поколений, сохранении и

развитии научных школ носит далеко не риторический характер.

Вследствие того, что нередко руководители органов и учреждений

здравоохранения не всегда владеют статистическими методами, становятся нередкими

случаи неверной интерпретации исходных данных и рассчитанных

показателей, а выводы, сделанные на этой основе, не просто неверны, но и

зачастую вредны. До сих пор у нас продолжаются сравнения несравнимых

данных, без понимания различий в определениях, методах измерения, без

стандартизации и т. д.

До сих пор, анализируя демографические показатели, показатели

ресурсов и деятельности здравоохранения, делаются неправильные выводы, что

свидетельствует о чрезвычайно поверхностной подготовке целого ряда

политических, общественных и медицинских деятелей. Когда их спрашива-

9

ешь, например, какое население Вы использовали (наличное, постоянное,

на начало года, на конец года, среднегодовую численность, в том числе

рассчитанную как среднеарифметическое, среднегеометрическое, средне-

гармоническое или взвешенное и т. д.) или что входит в ВВП и как он

исчисляется, то в глазах видишь полное изумление.

Именно по указанным выше причинам мы допустили отставание от

многих западных стран в проведении широкомасштабных

эпидемиологических исследований (еще недавно термин "эпидемиология" у нас

относился к инфекционным болезням и применялся не только для изучения их

распространенности, но и для оценки триады Л. В. Громашевского:

источник — механизм — реципиент) и особенно в области клинической

эпидемиологии, оформленной в виде науки 30 лет назад. А это в свою очередь

повлияло на доказанность и верность выводов, на политику в области

здоровья и здравоохранения, на проведение рандомизированных

исследований, на развитие доказательной медицины, т. е. на установление связей

между результатами и технологиями, а значит, на обеспечение качества

медицинской помощи. Еще раз напомню, что в основе этого отставания

находится отсутствие достаточных и широких взглядов в области

статистики.

Вот почему так актуально и необходимо настоящее руководство,

представленное на рассмотрение читателю. Оно получилось большим,

сложным, достаточно математизированным и имеет известные достоинства и

недостатки. В то же время оно просто необходимо для использования в

первую очередь в преподавании дисциплины, а затем — для

исследовательской и аналитической работы.

В настоящем руководстве будет сделана системная попытка показать,

каким образом методы математической статистики, распознавания образов

и прогнозирования можно применить к описанию и моделированию такой

"диффузной", плохо организованной системы, как здоровье населения.

Действительно, принципиально невозможно установить жесткие

функциональные зависимости между величинами заболеваемости,

нетрудоспособности, смертности населения и др. и полом, возрастом, профессией,

социально-бытовыми условиями и т. д., хотя, несомненно, зависимости каких-

то типов здесь все же существуют.

Во введении в настоящее руководство мною сформулированы основные

принципы применения методов математической статистики в медицине и

биологии, изложенные в виде обзора.

В дальнейшем авторами в первом томе представлены случайные

события, случайные величины и системы случайных величин, методы

анализа полученных данных, статистические критерии, исследование

зависимости групп наблюдений, причем рассматриваются как

параметрические, так и непараметрические методы. Существенное внимание

уделено интерпретации полученных результатов. Рассмотрены

многочисленные примеры. Во втором томе проанализированы современные

представления о статистике здоровья и здравоохранения.

10

Таким образом, заинтересованный читатель может получить достаточно

подробную информацию о статистических подходах, методах и приемах и

использовать их в своей повседневной работе.

Комаров Ю. Л/., доктор медицинских наук,

профессор, заслуженный деятель науки РФ

Посвящается светлой памяти

первого президента Новгородского

государственного университета академика

Сороки Владимира Васильевича

Глава I. СЛУЧАЙНЫЕ СОБЫТИЯ. ВЕРОЯТНОСТЬ

1.0. О теории вероятностей и вероятностных методах

Окружающий нас мир представляет огромное многообразие различных

явлений, процессов, событий, взаимосвязанных между собой

бесчисленными нитями причинно-следственных зависимостей. В большинстве

явлений хитросплетение множества различных связей настолько сложно, что

предсказать заранее осуществление того или иного события не

представляется возможным. Например, невозможно предсказать точно, сколько лет

проживет конкретный ребенок, родившийся сегодня абсолютно здоровым.

Невозможно точно предсказать, когда и какими болезнями он

переболеет, с какими последствиями, каковы параметры его здоровья будут через

20 лет и вообще доживет ли он до этого возраста. Даже внешние данные

(рост, масса тела) заранее вычислить невозможно. Точно так же мы до

определенного времени не можем знать, в каком возрасте этот человек

вступит в брак (и женится ли вообще?), сколько будет иметь детей, сколько

мальчиков и сколько девочек, какую профессию он изберет и в какой

местности будет жить и т. д. За словами "т. д." кроется бесконечное

количество вопросов, на которые невозможно до определенного момента (до

осуществления испытания) дать однозначные ответы. Причина этого

"незнания" объясняется обилием случайностей, которые сопровождают нашего

новорожденного на протяжении всей жизни. И если каких-то

случайностей можно сознательно избежать, то на их место придут другие

случайности. Следует отметить, что случай играет как негативную, так и

позитивную роль, примеров тому любой читатель может привести предостаточно.

Наличие неопределенности исхода проявляется не только на большом

временном отрезке, но и в каждое следующее мгновение. Например,

подбрасывая стандартную монету, мы не можем гарантировать исход данного

испытания: однозначно выпадение "орла" или выпадение "решки". Даже если

испытания будут проводиться при сравнительно одинаковых условиях (в

частности, пусть монетка подбрасывается специальной сверхточной

"бросательной машиной"), нет никакой гарантии, что малейшее неуловимое

отклонение от начальных условий не приведет наши испытания к

различным исходам.

Случайность всеобъемлюща, она проявляет себя во всех явлениях

окружающего нас мира, будь то физические, химические, биологические,

социальные и другие процессы.

12

Однако доля неопределенности, доля случая в разных ситуациях

совершенно различна. И если исход одних явлений становится полной

неожиданностью, то в других компонента случайности столь мала, что результат

прогнозируется практически однозначно. Например, набирая номер

телефона, мы не сомневаемся, что на другом конце провода раздастся звонок,

или, смешивая растворы Ва(ОН)2 и H2S04, обязательно получим осадок

молочно-белого цвета. В то же время мы с гораздо меньшей уверенностью

можем утверждать, что набираемый нами абонент окажется у телефона,

или, смешивая произвольные растворы, получим предполагаемый эффект.

Резюмируя сказанное, можно утверждать, что практически все явления

окружающего нас мира происходят с той или иной степенью

неопределенности, спектр которой простирается от полной непредсказуемости до

несомненной однозначности исходов.

При такой точке зрения естественно ввести некоторую характеристику

явлений, выражающую меру неопределенности или меру нашей

уверенности в исходе испытания. Рассматривая численное выражение этой меры,

можно случайность не только описывать, но и исследовать, учитывать и

использовать для прогноза.

Меру нашей уверенности восходе испытания.и . ^шыдавдизюэдято-

стью. Вероятность — объективная характеристика. Во избежание возмож-

ньТхНнедоразумений, разночтения, субъективности исследователя

необходимо ввести более точное определение термина "вероятность" и подчинить

ее (вероятность) некоторым правилам, соответствующим здравому смыслу

и не противоречащим жизненному опыту. Наука, в основу которой

положено понятие вероятности и которая занимается_выявлением_и изучением

закономерностей в случайных явлетШ^з^ы^ё^^Т^Ш^ЗЁРШТМО&Х^-

Теория вероятностей — наука математическая, так как широко

использует математический аппарат, но область приложений этой науки

безгранична. Численная интерпретация случайности позволяет находить

специфические закономерности, специфические вероятностные законы, что в

конечном итоге опровергает тезис о хаотичности, бессистемности

случайных явлений. В настоящее время появились новые науки,

разрабатывающие тактику и методы действия в среде со случайными факторами: теория

массового обслуживания, теория случайного поиска, теория игр, теория

катастроф и некоторые другие.

Чем далее развивается наука, тем более аргументированными

становятся положения о вероятностной основе окружающего мира: мир построен

на вероятности.

Классическая наука исследует, как правило, детерминистические

закономерности: например, площадь любого треугольника равна '/2 ah, длина

пути при равномерном движении всегда равна vt. Эти соотношения

справедливы при любом исходе испытания (в данных конкретных случаях при

измерениях используемых параметров). В случае с подбрасыванием

стандартной монеты исход испытания неоднозначен и детерминистической

закономерности выпадения "орла" или "решки" нет. Используя

вероятностный подход, можно утверждать, что «вероятность выпадения "орла" равна

У2» (т. е. 50 %). Смысл этого утверждения в следующем: если данное

испытание производить достаточно большое количество раз, то "орел"

появится в среднем в 50% исходов. Детерминистические закономерности, та-

13

ким образом, являются частным случаем вероятностных, т. е. события

npoHcxoAHT^js^ofliimcii^J^^j'pp^^cnbiTaHHft). Для многих задач

вероятностная оценка результата является вполне удовлетворительной.

Следует отметить, ЧТО TPnjwg_ggpnirmnr.Tfttt ичучяр/г только массовые яв-

ления, а именно: явления, которые могут быть повторены достаточно

большое количество раз, а теоретически и бесконечное число раз. Теория

вероятностей изучает события, обладающее статистической, устойчиво^

стью, т. е. события, относительная частота появления которых с ростом

количества испытаний стабилизируется, колеблется около некоторого

значения (именно это значение и будем считать вероятностью

рассматриваемого события). Этот факткакраз jl выражает, закономерность в среде

случайности. Как известно из курса философии, поихт^а^ШЧййнодх^лз^н&о^-

ходимостй,_ случайности и закономерности (порядка) диалектически

йаТтао^ЖаньГ.Хвязующеё звено между этими"антагонисте

тйямй — комплекс условий, при которых происходит случайное явление

(испытание). Дри многократном повторении испытаний комплекс условий

должен оставаться неизменным. При этом из^ножества случайностей

вырисовываются закономерность и"гТорядо"к, которые и находят свое выражё-

ние в понятии вероятности. ф&ШТЯ&£^У№зШ&&Т'Ш 'Нал*йчйеГ*а также

[степе^^вязи^комплекса условий и осуществления случайного события. _

^ори^_МР^ятностёи не изучает уникальные^события: события, которые

заведомо нельзя считать многократно повторяющимися или массовыми.

Например, события (высказывания) —

к 2005 г. будет найдено эффективное лекарство против СПИДа;

в 1980 г. нынешнее поколение будет жить при коммунизме;

следующим президентом страны будет избран гражданин N;

в 1994—1996 гг. в Ядранском (Адриатическом) море будет выловлена

"дивная рыба с человеческой головой" (предсказание Нострадамуса) —

относятся к уникальным. И хотя указанные события, безусловно, содержат

в себе элементы случайности — могут произойти или не произойти, они

(так же как, впрочем, и их авторы) к теории вероятностей отношения не

имеют. Произойдут ли данные события — может показать только время.

Рассматривая вероятность как меру неопределенности, следует

опираться на знания, на информацию, извлеченную из наблюдения и из

предшествующего опыта. Ни в коем случае нельзя при отсутствии

информации объявлять возможные исходы испытания равновероятными,

ибо в этой ситуации наши рассуждения базируются на незнании, что

обычно не приводит к позитивным результатам. По той же причине в

теории вероятностей не рассматриваются и уникальное события: нельзя

основываться на незнании, а знание закономерностей, следовательно, и

вероятностей извлечь неоткуда, так как отсутствует "пЪТГгбр^ёмость собы"~

тий и их массовость.

Отметим также не только субъективность, но и объективную природу

случайности, которой присущи в массовых явлениях свои специфические

черты, не проявляющиеся в отдельных испытаниях.

Следует подчеркнуть особую роль в вероятностных исследованиях

статистики, которая является практической копией теории вероятностей.

Именно статистика поставляет данные, необходимые для применения

вероятностных методов.

14

Учитывая эту специфику, можно утверждать, что во многих

практических задачах в самых различных областях естествознания и деятельности

человека вероятностный подход является наиболее целесообразным и

соответствующим объективной истине.

В частности, современная медицина, имеющая объектом

исследования множество индивидуумов, отличающихся друг от друга по

всевозможным различным показателям, имеет вероятностную основу и широко

использует вероятностные и статистические методы. Без знания этих

методов невозможно осмысление целого ряда медико-биологических

научных дисциплин, и эффективная деятельность медицинского работника

существенно зависит от его компетентности в области применения

указанных методов.

1.1. Основные понятия и определения

В предыдущем параграфе мы вольно, исходя из обыденного смысла,

употребляли многие термины, значение которых необходимо определить

более четко. В противном случае неминуемо придем к разночтению,

двусмысленности и в конечном итоге к непониманию. Поэтому

представляется крайне важным для многих используемых понятий определить их в

нужном нам смысле. Строгость таких определений различна и зависит в

основном от уровня математичности изложения.

Условимся испытанием называть ася^ш_0ДЬ1тг при проведение

которого задана совокупность условий, неоднозначно пр!гдЪпределяющая исход

этого опыта. — — - —

Несколько примеров испытаний:

— подбрасывание игральной кости с выпадением какой-то грани, на

каждой из которых указано количество очков от одного до шести;

— перепад атмосферного давления и температуры воздуха;

— способ лечения данного заболевания;

— некоторый период жизни человека и т. д.

Результатом данного испытания будет какое-то произошедшее явление,;

а точнее одно из возможных явлений, которые могли бы осуществиться/

Эти явления принято называть случайными событиями. Таким образом,

случайным co6Tirae~M~~no отношению к данному испытанию называют

явление, которое может произойти или не произойти в зависимости от

исхода этого испытания.

Условимся обозначать случайные события большими буквами

латинского алфавита: А, В, С, .... Например, при испытании, заключающемся в

подбрасывании игральной кости, возможные случайные события — это:

Ах — выпадение одного очка;

А2 — выпадение двух очков;

А€ — выпадение шести очков.

Эти события простые (элементарные), однако по отношению к данному

испытанию можно найти и другие случайные события, получающиеся из

элементарных: А — выпадение четного числа очков; В — выпадение числа

очков, больших чем 4; С — выпадение числа очков, кратного 3 и т. д.

15

Таким образом, с испытанием связывают некоторое множество

случайных событий, осуществление которых возможно в результате данного

испытания. Например, степени обострения ишемической болезни

сердца, включая случаи смерти, являются случайными событиями при

испытании — резком повышении температуры воздуха зимой.

Чтобы со случайными событиями производить какие-то операции типа

арифметических — сложения, умножения1, необходимо к множеству

случайных событий добавить еще два: невозможное событие (играет роль

нуля или, точнее, пустого множества — (0) и достоверное событие

(охватывает все множество возможных событий).

Случайное.j£o§^1^.M^M^1^t достоверным по- оти©1некикг-к~ данному

испытанию, если оно осуществляется при любом исходе этого испытания.

УслбвТшся достоверное событие обозначать буквой U.

Случайное событие называют невозможным по отношению к данному

испытаниГО7"е"слтгоно неосуществимо при любом исходе этого испыта«ия.

Также условимся обозначать невозможное £o6biiHeJ5jKj3oJM^

Следует отметить, что все события определяются по отношению к

данному испытанию, т. е. события являются следствием определенного

комплекса условий, предполагаемых при испытании. Изменение этих условий

влечет изменение результата испытаний: меняется взаимосвязь множества

случайных событий, вплоть до того, что событие) невозможное при одном

комплексе условий, может оказаться вполне реальным (или даже

достоверным) при других условиях. Поэтому теория вероятностей, изучая

случайные события, всегда связывает их с определенным испытанием. Если же

испытания повторяются, то предполагается, что комплекс условий,

сопровождающий испытания, неизменен.

Два события А и В называют эквивалентными (или равносильными) по

отношению к данному испытанию, если из факта осуществления одного

из них следует обязательное осуществление другого: например, из

осуществления А следует осуществление В, а из осуществления В следует

осуществление А. Эквивалентные события обозначают обычным равенством:

А = В. Пример эквивалентных событий при бросании игральной кости: А —

выпадение "шестерки", В — выпадение четного числа очков, большего

четырех.

Введем операции сложения и умножения случайных событий.

Суммой случайных событий А и В называют случайное событие С,

состоящее в осуществлении хотя бы одного из событий-слагаемых.

Обозначение: А + В = С. Если события представить как множества А и В (рис.1),

то суммой событий называют объединение этих множеств (AvB). На рис.1

объединением множеств является заштрихованная область, которая

состоит из трех частей: 1-я — осуществляется только событие А и не

осуществляется В; 2-я — осуществляется только событие В, и не осуществляется А;

3-я — осуществляется и событие А, и событие В (общая часть, т. е. их

пересечение).

'Более точное соответствие случайных событий не с числами, а с множествами. Тогда

операции сложения соответствует объединение множеств (AKJB), а операции умножения —

пересечение множеств (АГ\ В).

16

А* В АВ

Рис. 1. Рис. 2.

Произведением случайных событий А и В называют случайное событие С,

состоящее в осуществлении и события А, и события В. Обозначение

А • В = С. Если события представить как множества А и В, то

произведением событий является пересечение множеств (Агл В) (см. заштрихованную

часть на рис. 2).

Пример. Испытание заключается в извлечении случайным образом из

тщательно перетасованной стандартной колоды, состоящей из 36 карт,

одной карты. Случайное событие А — извлечение карты бубновой масти;

случайное событие В — извлечение туза любой масти.

При данном испытании предполагаемым комплексом условий является

следующая система:

— имеется стандартная колода из 36 карт определенного состава (4

различные масти по 9 карт от "шестерки" до "туза");

— карты в колоде располагаются случайным образом, что достигается

тасованием, и извлекаемая карта берется наудачу.

При этих условиях суммой событий А + В является событие, состоящее

в появлении либо любой бубновой масти (от "шестерки" до "туза"), либо

появление "туза" любой масти, включая бубновую.

Произведением событий А • В является событие, состоящее в появлении

туза бубновой масти.

Заметим, что в данном примере при изменении комплекса условий,

например при замене колоды на стандартную из 52 карт, приходим к

изменению структуры события А и события А + В, а также изменению всего

множества случайных событий, связанных с испытанием.

Для действий над событиями справедливы следующие свойства:

I. А + В = В + А;

2.{А + В)+С = А + (В+С);

З.А + А = А;

4.А-В = В-А;

5. (А-В)- С = А-(В-С);

6.А-А = А;

7.{А + В)-С = А- С+ В-С.

Свойства достаточно простые и естественные, однако следует обратить

отдельное внимание на 3 и 6, справедливость которых непосредственно

следует из определений суммы и произведения случайных событий.

Далее сформулируем некоторые определения, еще раз подчеркивая, что

все они вводятся по отношению к данному испытанию.

2 — 3529

17

Случайные события А и В называют несовместными, если их

произведение является событием невозможным: А • В = V (т. е. А и В не могут вместе

одновременно осуществиться в одном испытании).

Систему п случайных событий Ех, Е2, ..., Еп называют полной, если

сумма событий является событием достоверным: Ех+Е2+ ...+ Еп= U. Таким

образом, хотя бы одно из событий системы Ех, Е2, ..., Еп происходит при

любом исходе испытания.

Систему п случайных событий Ех, Е2, ..., Еп называют несовместной,

если любые два события системы являются событиями несовместными:

Е/' Ej= Уддя всех i = 1, 2, ..., n;j = 1, 2, ..., п; i*j.

Систему п случайных событий Ех, Е2, ..., Еп называют равновозможной,

если никакое из событий системы в своем осуществлении не имеет

приоритетов по отношению к другим событиям системы.

Систему случайных событий называют полной системой элементарных

событий, если эта система полная, несовместная и равновозможная. При

этом слово "элементарное" применительно к случайному событию,

предполагает, что данное событие является простым, а не составным и не

разбивается на систему более простых. Заметим, что понятие элементарного

события столь же неопределяемо, как и понятие точки в геометрии.

Например, при испытании, заключающемся в случайном выборе одной

карты из стандартной колоды в 36 карт, полная система элементарных

событий содержит 36 событий: Ех, Е2, ..., Е^. Каждое их этих событий

состоит в появлении одной из 36 различных карт. Эта система действительно

полная (одна из 36 карт обязательно появится), несовместная (извлеченная

карта одновременно не может быть, например, "шестеркой пик" и "валетом

треф"). Равновозможность обеспечивается случайным выбором. При этом

наряду с элементарными мы можем рассматривать и другие случайные

события, в частности:

А — появление "туза" (состоит из объединения четырех элементарных

событий);

В — появление карты бубновой масти (состоит из объединения девяти

элементарных событий) и т. д.

Событие А называют благоприятствующим событию В, если из

осуществления А следует осуществимость события В.

Событие А называют неблагоприятствующим событию В, если из

осуществления события А следует неосуществимость события В.

Например, испытание — подбрасывание игральной кости. Полная

система элементарных событий состоит их шести случайных событий Ех, Е2,

..., Е6 — выпадение соответствующего количества очков. Событие В —

выпадение четного числа очков. Для события В благоприятствующими

являются следующие события: Е2 — выпадение "двойки", ЕА — выпадение

"четверки", Е6 — выпадение "шестерки". Неблагоприятствующими для события

В будут следующие события: Ех — выпадение "единицы", Е3 — выпадение

"тройки" и Е5 — выпадение "пятерки".

18

1.2. Понятие о вероятности случайного события

Введенные выше случайные события должны иметь некоторую

характеристику, опираясь на которую можно судить о степени ожидаемости того

или иного события. Данная характеристика должна быть объективной, т. е.

зависеть не от мнения автора прогноза, а от комплекса условий, при

которых происходит испытание, и соответствующей многократно

повторяющимся наблюдениям. Данная характеристика должна быть универсальной,

так как призвана характеризовать случайные события самой различной

природы. Вводимая характеристика должна позволять сравнивать и

сопоставлять различные события по степени их достоверности.

Вывод — всем перечисленным условиям удовлетворяет числовая

характеристика, т. е. каждому случайному событию в испытании ставят в

соответствие некоторое число, которое и называют вероятностью

рассматриваемого события. Обозначают вероятности так же, как и функции: Р(А) —

вероятность события А в заданном испытании. Часто для удобства записи

аргумент не пишут, а для значения вероятности используют строчные

латинские буквы, например Р(А) = р, Р(В) = q , Р(АХ) = рх и т. д.

На виде рассматриваемого соответствия и правилах вычисления

остановимся позднее в последующих параграфах. Однако следует подчеркнуть, что

понятие вероятности вводится точно так же, как многие понятия в известном

школьном курсе геометрии. Например, никого не удивляет и не вызывает

особых трудностей понятие площади плоской фигуры, в основе которого тоже

лежит соответствие между свойствами фигуры и числами. По определению

вводится число а2, соответствующее одной из самых простых фигур, квадрату со

стороной а, затем указываются способы вычисления площадей

прямоугольника, прямоугольного треугольника, произвольного треугольника,

многоугольников. Используя понятия предела, а затем определенного интеграла,

вычисляются площади круга, криволинейной трапеции и далее площади фигур

произвольной формы, а также и площади поверхностей различных объемных тел.

Аналогично вводится в геометрии и понятие объема тел. По мере усложнения

структуры исследуемых объектов возникают новые связи между понятиями,

новые определения, выявляются новые закономерности.

Аналогично построена и теория вероятностей. В роли простейшей

геометрической фигуры — квадрата — выступает полная система

элементарных событий, введенная в § 1.1. Простота этой системы определяется

конечным числом элементарных событий и особенно условием равновоз-

можности (сравните с равенством сторон квадрата). Для полной аналогии

можно сопоставить условие несовместности событий в полной системе

элементарных событий с наличием прямых углов в квадрате.

Таким образом, если Вы хотите в теории вероятностей достичь уровня,

соответствующего умению в геометрии вычислять площади квадрата и

некоторых близких к нему фигур, достаточно изучить классическое определение

вероятности и некоторые приемы комбинаторики. Однако если Вы занимаетесь

более сложными проблемами, нежели задачи, связанные с простым

пересчетом вариантов, следует иметь представление и о более общем определении

вероятности, а также оперировать понятиями: случайная величина, функция

распределения, закон распределения, числовые характеристики случайных

величин, корреляция, регрессия и др. Обо всем этом далее и пойдет речь.

1.3. Классическое определение вероятности

Пусть по отношению к данному испытанию имеем полную систему

элементарных событий Ех, Е2, ..., Еп. Событие А таково, что любое из

событий системы либо благоприятствует осуществлению А, либо не

благоприятствует. Обсуждаемую ранее возможность осуществления события А

определим с помощью числовой характеристики (меры), которую и

назовем вероятностью случайного события.

Определение. Вероятностью случайного события А называют число,

обозначаемое Р(А) и равное отношению т/п, где п — число всех

элементарных событий системы; т — число элементарных событий в системе,

благоприятствующих осуществлению А.

Таким образом, введена простая формула

Р(А) = 2.

п

В соответствии с этой формулой справедливы свойства вероятности:

Свойство 1. Вероятность любого случайного события является числом

неотрицательным.

Справедливость данного соотношения следует из неотрицательности

чисел тип.

Свойство 2. Вероятность любого случайного события всегда

удовлетворяет двойному неравенству

0<Р(А)<\.

Справедливость данного соотношения следует из простого факта, что

О < т < п, который означает, что число событий, благоприятствующих А,

не больше, чем число всех элементарных событий системы и, конечно же,

не меньше нуля.

Свойство 3. Вероятность достоверного события равна 1. (P(U) = 1).

Это верно, так как для достоверного события благоприятствующими

являются все п событий системы:

P(U) = n/n= 1.

Свойство 4. Вероятность невозможного события равна нулю.

(P(V) = 0).

Утверждение верно, так как для невозможного события среди полной

системы элементарных событий благоприятствующих нет:

P(V) = О/л = 0.

Пример. Из стандартной колоды в 36 карт наудачу выбирается одна

карта. Найти вероятность, что выбранная карта является тузом (масть роли

не играет).

Решение. Обозначим искомое случайное событие символом А. Полная

система элементарных событий состоит из 36 событий (п = 36), среди

которых благоприятствующими для осуществления А являются 4 события,

так как в колоде 4 туза (т = 4). Таким образом, по введенной выше

формуле получаем

Р(А) = т/п = 4/36= 1/9.

Смысл найденного числа (вероятности) состоит в следующем: если

данное испытание — извлечение карты — проводить многократно, то в

среднем доля случаев появления туза (безразлично какой масти) составит при-

20

близительно % среди всех исходов испытаний. И чем больше испытаний

проводится, тем точнее эта доля соответствует %.

Отметим, что однократное появление туза в 9 испытаниях является

наиболее вероятным событием, наиболее ожидаемым и не более того: в

конкретных 9 испытаниях туз может появиться любое число раз от нуля до

девяти. А для проявления вероятности необходима массовость испытаний.

1.4. Элементы комбинаторики

Вычисление вероятностей случайных событий в условиях классического

определения в конечном итоге сводится к пересчету различных вариантов,

к пересчету количества комбинаций. А эти вопросы о количестве

комбинаций, которые можно составить, имея элементы произвольной природы,

относятся к компетенции раздела дискретной математики, называемого

комбинаторикой. Отметим, что многие формулы, методы и приемы

комбинаторики используются не только в собственно математических

дисциплинах, но и в областях визуально исторически достаточно далеких от

математики: биологии, медицине, логике, лингвистике и др.

Вначале рассмотрим примеры.

Пример 1. В магазине в продаже имеется 5 видов хлеба и 15 видов

колбас. Сколькими способами можно составить бутерброд (имея в виду

определенный вид хлеба и определенный вид колбасы)?

Решение. Хлеб можно выбрать пятью различными способами, и с

каждым из этих способов комбинируется один из 15 видов колбасы, т. е. с

хлебом первого вида можно составить 15 различных бутербродов, с хлебом

второго вида — 15 бутербродов и т. д. Суммируя все способы, получаем:

общее количество видов бутербродов равно 5 • 15.

Ответ: существует 75 способов составить бутерброд.

Пример 2. Из пункта А в пункт В ведут 4 дороги. Из пункта В в пункт С

ведут 3 дороги. Сколькими способами можно проехать из А в С через В?

Решение. Для наглядности сделаем рисунок.

Пронумеруем дороги от А до В (рис. 3). Если из А в В ехать по 1-й

дороге, то из А в С можно добраться тремя способами (от В до С — три

дороги); если из А в В ехать по второй дороге, то до С можно добраться опять

тремя способами и т. д. еще дважды по три способа для дорог 3-й и 4-й.

Всего, суммируя, получаем 4 • 3.

Ответ: существует 12 способов проехать из А в С через В.

1

Рис. 3.

21

В каждом из приведенных примеров мы применяем правило

умножения: перемножаем количество способов выполнения одного действия с

количеством способов выполнения второго действия.

Количество рассматриваемых действий может быть и более двух.

Рассмотрим соответствующий пример.

Пример 3. В первенстве университета по волейболу участвует 20

команд. Сколькими способами могут быть распределены золотая, серебряная

и бронзовая медали?

Решение. Золотую медаль может получить одна из 20 команд,

следовательно, имеется 20 способов. После того как золотая медаль нашла своего

владельца, серебряную медаль может получить одна из оставшихся 19

команд. Таким образом, золотую медаль можно распределить 20 способами,

с каждым из которых сочетается 19 способов распределения серебряной

медали. Всего 20* 19 = 380 способов распределения золотой и серебряной

медалей. После определения владельцев золотой и серебряной медалей

остается 18 претендентов на бронзовую медаль, т. е. для каждого из 380

способов имеется по 18 вариантов распределения бронзовой медали. А всего

380-18 = 6840 способов.

Ответ: существует 6840 различных вариантов распределения золотой,

серебряной и бронзовой медалей среди 20 команд.

Замечание. Во всех трех рассмотренных примерах мы пересчитываем

все возможные варианты, не отдавая предпочтения наиболее вкусному

бутерброду в примере 1, кратчайшему пути в примере 2 или наиболее

сильным командам в примере 3, т. е. пересчитывается количество возможных

комбинаций без учета вероятностей выбора отдельных вариантов. Точнее,

все возможные варианты предполагаются равновероятными.

Исходя из рассмотренных примеров, сформулируем правило

умножения, называемое основным правилом комбинаторики -

Пусть необходимо выполнить одно за другим А:-действий (например,

выбрать объект из какого-то множества). При этом первое действие

возможно выполнить /и, способами, второе действие — т2 способами и т. д.

до к-го действия, которое выполнимо тк количеством способов. Тогда все

^-действия можно выполнить т способами, где

Задание. Вернитесь к рассмотрению предыдущих примеров 1, 2, 3 и в

каждом из них найдите, чему равно к и какие значения принимают

величины тх, т2,..., тк.

Рассмотрим следующие примеры.

Пример 4. Изменим условия примера 2, а именно (см. рис. 4): из

пункта А в пункт В ведут 4 дороги; из пункта В в пункт С ведут 3 дороги; из

пункта А в пункт D ведут 2 дороги, а из D в С ведут 5 дорог. Сколькими

способами можно добраться от пункта А до пункта С?

Решение. По условию задачи (см. рис. 4) из пункта А в пункт С можно

добраться либо через В, либо через D. Согласно правилу произведения (см.

пример 2), существует 12 способов выбора пути через В. Аналогично через

22

Рис. 4.

D в С можно добраться 10 способами (2 • 5). Общее количество возможных

путей можно найти, объединив число путей, проходящих через В с числом

путей, проходящих через D: 12+10.

Ответ: существует 22 различных способа выбора пути из пункта А в

пункт С.

Пример 5. Имеются три серии книг: "фантастика" — 20 различных книг,

"приключения" — 25 различных книг, "детектив" — 30 различных книг.

Сколькими способами можно выбрать две книги обязательно различных

серий?

Решение. С учетом различных серий можно выбрать либо "фантастика"

и "приключения" (20 • 25 способов), либо "фантастика" и "детектив" (20 • 30

способов), либо "приключения" и "детектив" (25 • 30 способов). Общее

количество вариантов выбора двух книг получаем, объединяя все возможные

способы: 20 • 25 + 20 • 30 + 25 • 30 = 1850.

Ответ: существует 1850 различных способов выбора.

Резюмируя примеры 4, 5, сформируем правило суммы.

Пусть некоторое действие Ах (например, выбор объекта из какого-то

множества) можно выполнить /и, способами, а другое действие А2 можно

выполнить т2 способами. Тогда выполнить только одно из действий, либо

Ах, либо А2, можно т способами, где)т = тх + т?\

Замечание. Данное правило легко распространяется с двух действий на

^-действий, где к = 3, 4, 5, ... . Тогда соответственно количество способов

выполнить лишь одно действие равно т = /и, + т2 + ... + тк.

Задание. Вернитесь к примерам 4, 5 и в каждом из них найдите, чему

равно к и какие значения принимают т = тх + т2 + ... + тк.

Далее введем некоторые определения и формулы.

Определение. Произведение первых п натуральных чисел.,1 ■ 2- 3 •... • п

обозначаютд^и называют п-факториал, т. е. «J,= 1 • 2. • 3 •... • п.

~~ В"частностиГ1Г= Т,"2\~=X # ="6, 4Г= 24 и'т. д!

Для существования некоторых формул удобно ввести величину 0!, по

определению полагая 0! = 1.

Определение. Комбинации п различных элементов, отличающиеся

лишь порядком расположения этих элементов, называют перестановками.

Найдем, сколько перестановок можно получить, меняя местами п

различных элементов при конкретных п. Пусть имеется один элемент а. В

23

этом случае комбинировать не с чем, следовательно, имеется лишь одна

перестановка. Обозначим ее Рх, тогда Рх = 1 = 1!

Пусть имеется два элемента: а, Ь. Тогда количество перестановок равно

2, а именно: аЬ и Ьа, т. е. Р2 = 2 = 2!

Рассмотрим три элемента: а, Ь, с. В этом случае возможных

перестановок 6, а именно: abc, acb, bac, bca, cab, cba. Рг = 6 = 3!

В общем случае справедлива формула Рп = п! Действительно, если

имеется п элементов, то упорядочить их можно следующим образом: на первое

место поставить любой из п элементов, на второе место — любой из

(л — 1) оставшихся, на третье — любой из (л — 2) оставшихся и т. д., на

последнее л-е место претендует лишь один оставшийся элемент.

Применяя правило произведения, находим

Рп = п{п- 1)(л-2) ... 21 =п\ (1.1)

Пример 6. Сколько различных чисел можно составить, используя в

записи числа лишь пять неповторяющихся цифр: 1, 2, 3, 4, 5?

Решение. Каждое из чисел, например 12 3 4 5 или 5 4 3 2 1, является

перестановкой из пяти различных элементов. Тогда общее количество

возможных чисел равно Р5 = 5! = 120.

Пусть снова имеется л-различных элементов. Усложним задачу:

требуется выбрать из п элементов ровно т, где т — некоторое целое число,

0 < т <п. Например, из 10 элементов нужно выбрать 3 элемента. При этом

необходимо различать два случая: важен порядок выбора элементов или

неважен. К примеру, выбраны из 10 три элемента: а,Ь,с. В первом случае,

когда учитывается порядок следования элементов при выборе,

комбинации (перестановки) abc, acb, bac, bca, cab, cba считаются различными и их

ровно Р3 = 3! (в общем случае т!). Во втором случае, когда порядок

следования элементов при выборе безразличен, все 3! приведенных комбинаций

(в общем случае т!) считаются за одну. Следовательно, таких комбинаций

в общем случае выбора т элементов из п ровно в т\ раз меньше, чем в

случае упорядоченного выбора.

Найдем, сколько же их в обоих случаях.

При упорядоченном выборе т элементов из п первый элемент может

быть любым и выбран соответственно п способами. Для выбора второго

элемента остается (л — 1) способов и т. д., для выбора m-го элемента

остается (п — т + 1) способов. По правилу произведения в итоге получаем

п(п — 1)...(« — т + 1) способов.

Заметим, что при т = п получается произведение всех натуральных

чисел от 1 до п, т. е. множество перестановок Рп. В нашем случае, когда т,

вообще говоря, меньше п, это множество неполное.

Определение. Комбинации по т элементов, выбранные из множества п

различных элементов, отличающиеся либо составом элементов, либо их

порядком, называют размещениями.

Количество всех возможных размещений принято обозначать Апт, и, как

только что установлено, справедлива формула:

Апт=п(п- 1) ... (п- т+ 1), (1.2)

где т = 1, 2, 3, ..., п.

24

Отметим, что если данное произведение домножить на

1 • 2 • 3 •... • (п — т) = (п — т)\ , то получим п!

Таким образом Апт • (л - т)\ = п!, следовательно,

Апт=—^—. (1.3)

Найденная формула имеет смысл и при т = 0, а именно: Ап°= 1.

Рассмотрим второй случай: случай, когда т выбранных элементов не

различают по порядку выбора.

Определение. Комбинации по т элементов, выбранные из множества п

различных элементов, отличающиеся по составу хотя бы на один элемент,

называют сочетаниями по т элементов из п.

Количество сочетаний по т элементов из п принято обозначать Спт.

Как уже установлено ранее, количество сочетаний Спт меньше

соответствующего количества размещений в т\ раз. Таким образом, справедлива

формула (1.3).

Ст = я- (\ л)

m!(/i-m)!' v ' ;

где т = 0, 1,2 ... п.

Пример 7. В спортивной секции занимается 10 человек. Сколькими

способами можно отобрать команду, состоящую из 6 человек?

Решение. Поскольку порядок отбора игроков в команду несуществен,

то всего имеется С,60 способов; см. (1.4). Вычислим это значение, сокращая

одинаковые сомножители в числителе и знаменателе дроби:

пв _ 10! _ 10! _ 10 ■ 9 ■ 8 ■ 7 _ 10 ■ 9 • 8 ■ 7 _ 1П о 7-ип

Cl0~6!(10-6)! " 614! 4! 1 .2-3-4 " Ю ' 3 ' 7 - 210.

Ответ: существует 210 способов отбора.

Пример 8. В аудитории 25 мест. Сколькими способами можно

рассадить на них 4 студентов?

Решение. Судя по условию задачи, порядок размещения студентов

должен быть учтен, т. е. речь идет не о сочетаниях, а о количестве

размещений A*s\ см. (1.2):

А" = Щ=Т) = Ш. = 25' 24 ' 23 ' 22 = 303 600'

Ответ: 303 600 способов.

Отметим, что количество сочетаний по m элементов из п используется в

формуле бинома Ньютона:

(а + л:) =С°аПх°=СП1ап-1х1 + ... +Cnma"-mxm + ... +С"а°хп. (1.5)

\ / л л л л л х'

Данная формула является обобщением известных равенств для п = 2 и

л = 3:

{а + х)2= а2+ 2ах+ х2=С°а2х°+С}а1х1 + С2а°х2

(а + хУ = а3 + За2х+ Зах2 + х3 =C3Vjc° +C3W + C2alx2+ C]a'x\

25

Используя знак суммирования, формулу бинома Ньютона можно

записать короче:

л

(а + х)п = £ Смпап~мхм. (1.6)

/п = 0

Величины Спт, являющиеся коэффициентами при степенях а и х,

называют биномиальными коэффициентами.

Биномиальные коэффициенты обладают многими интересными

свойствами.

Из формулы (1.4) следует, что Спт= Спп~т. (1.7)

Полагая в (1.5) а = 1, х = 1, получаем равенство, справедливое для

любого натурального п\

Сл°+ С,,1 + ... + СЛЛ = 2Л. (1.8)

Полагая в (1.5) а = 1, х= 1, получаем другое равенство, также

справедливое для любого натурального числа п:

С" С + Сп2 - ... + (-l)-C; = 0. (1.9)

Используя комбинаторные формулы и методы, можно вычислять

вероятности многих достаточно сложных событий.

1.5. Примеры

Рассмотрим некоторые примеры на применение формул

комбинаторики и нахождение вероятностей, используя классическое определение.

Пример 1. Назовем "словом" любую (даже бессмысленную)

комбинацию букв. Сколько "слов" можно получить, переставляя буквы в словах

a) ВРАЧ,

b) МЕДИЦИНА,

c) ПОЛИКЛИНИКА?

Решение, а) В слове ВРАЧ 4 различные буквы, В, Р, А, Ч, можно

переставить 4! = 24 способами.

b) В слове МЕДИЦИНА имеются две одинаковые буквы И. Очевидно,

что если в "слове" эти буквы И поменять местами, то само "слово" не

изменится. Также понятно, что если эти буквы считать разными, например,

пометив их И, и И2, to различных "слов" получится 8!. Снимаем пометки с

букв И, и тогда оказывается, что в количество из 8! слов все слова входят

попарно (например, МЕДИ, ЦИ2 НА и МЕДИ2 ЦИ, НА без пометок

становятся одинаковыми). Таким образом, различных "слов" вдвое меньше:

8!/2 = 20 160.

c) В слове ПОЛИКЛИНИКА 11 букв. Если бы они все были различны,

то количество их возможных комбинаций равно 11!. Однако наличие пары

букв Л уменьшает это количество в два раза, наличие пары букв К еще в

два раза, а три одинаковые буквы И уменьшают количество различных

слов еще в 3! раз (три буквы можно расставить по трем позициям 3! = 6

26

способами). Следовательно, различных "слов", получаемых из данного на-

0|

бора в 11 букв, всего = -—-^—— 1680.

2-2-3!

Пример 2. Ребенок играет четырьмя карточками из азбуки, на которых

написаны буквы М, М, А, А. Найти вероятность, что, расположив

случайным образом карточки в ряд, он получит слово "МАМА".

Решение. Используем классическое определение вероятности

Р{А) = т/п, где А — искомое случайное событие. Тогда п, аналогично

рассуждениям в примере 1, вычисляется как -—'—. Благоприятствующих

исходов т, причем т = 1. Таким образом, Р(А) = 1/61.

Пример 3. Генератор случайных чисел выдает на экран компьютера

шестизначное число. Считая все комбинации цифр равновозможными,

найти вероятность, что в записи числа присутствуют лишь нечетные

цифры.

Решение. Поскольку все комбинации цифр равновозможны,

используем классическое определение вероятности Р(А) = т/п, где А — искомое

случайное событие, п — количество всех шестизначных чисел:

п = 999 999 - 99 999 = 900 000. Число т найдем, используя правило

умножения. Шестизначное число — это шесть цифр, каждая из которых

записана на своей позиции. Таким образом, если все цифры нечетные (а

нечетных цифр всего пять), то на каждой из шести позиций шестизначного

числа может оказаться одна из пяти цифр. По правилу умножения общее

количество комбинаций из нечетных цифр т = 5-5-5-5-5-5 = 56.

Следовательно, искомая вероятность равна

Р(А) = т/п = ——-«0,0174.

9 • 105

Замечание. В примере 3 число п также можно было найти по правилу

умножения, учитывая, что всего различных цифр десять, и нуль не может

находиться на первой позиции:

я = 9 • 10 • 10 • 10 * 10 • 10 = 9 • 105.

Пример 4. Игральный кубик бросают 12 раз. Найти вероятность, что

каждое число очков выпадет дважды.

Решение. Считаем кубик правильным (симметричным, сделанным из

однородного материала), тогда все возможные исходы одного испытания

равновероятны, и вероятность выпадения любого количества очков от 1 до

6 равна 1/6. Проведя испытание 12 раз и опираясь на равновозможность

исходов в каждом испытании, также используем классическое определение

вероятности Р(А) = т/п, где А — искомое случайное событие. Найдем п и

т. Согласно правилу умножения и учитывая, что в каждом из 12

испытаний может осуществляться любой из шести исходов, п = б12 (см.

аналогичные вычисления в примере 3). Число благоприятствующих

событий-исходов равно числу различных последовательностей по 12 элементов таких,

1 В данной задаче можно количество всех исходов считать равным 4!, имея в виду

количество комбинаций из 4 различных карточек. Но тогда благоприятствующими для искомого со-

4 1

бытия окажутся ровно 4 способа размещения карточек, и вновь Р(А) = — = -? .

4 о

27

что все элементы обязательно входят парами: две единицы, две двойки и

т. д., две шестерки. Итак,

т - —-.

26

Тогда искомая вероятность:

ПА) = ^. = 0,0034-

Пример 5. В картотеке из 100 карточек имеется одна разыскиваемая.

Наудачу извлекается 10 карточек. Найти вероятность, что среди них

окажется требуемая.

Решение. Используем классическое определение вероятности. При этом

л-количество способов, которыми можно извлечь 10 элементов из

множества в 100 элементов, а именно: п = С,1^. Число благоприятствующих

способов т находится сложнее. Все множество карточек разбиваем на два

подмножества: одна карточка разыскиваемая и остальные 99 карточек.

Искомое событие А осуществляется, если одна карточка извлекается из

одноэлементного множества (количество способов —С\), а остальные девять —

из множества в 99 элементов (количество способов — С|9). Тогда т

находим по правилу умножения:

т= CiC999.

Зная тип, получаем:

рт_ С\С\\ = 99!Ю!90!

С,! 9!90!100!"

Сокращая близкие факториалы-сомножители в числителе и

знаменателе, находим

РШ=99!Ш! _ 1 ■ 10 _ 0 j

FW 10019! 100-1 U,i'

Пример 6. Из колоды в 36 карт выбирают наудачу три карты. Найти

вероятность, что

а) выбраны три туза; б) выбраны два туза.

Решение. Аналогично предыдущему примеру, все множество из 36 карт

разбиваем на два подмножества: 4 туза и оставшиеся 32 карты. Тогда в

случае а) все три карты извлекаются из первого подмножества, а в случае б)

две карты извлекаются из первого подмножества и одна — из второго

подмножества. Запишем ответы:

гл р(А) = С< = 4!3!33! = 4! _ 0 000.

*)Р(А) ~Щ6 ЗШ36! 34 • 35 • 36 ~ 0'°006'

&\ P(R\ = С4 • Сп _ 4!32!3!33! _ 3-2-32-3! _ п тм

)П) ~С]Г ~ 2!2!1!31!36! " 34-35-36 ~ °'0269'

Пример 7. Некто, имея 10 друзей, решил ежедневно приглашать

некоторых из них в гости так, чтобы компания ни разу не повторялась. В

течение какого времени это возможно?

28

ooo ooo oooo oooo

Рис. 5.

Решение. Искомое количество дней равно числу возможных компаний.

Компания может состоять из любого количества человек от одного до

десяти. Компанию из одного человека можно составить С,'0 способами, из

двух человек — С?0 способами и т. д. Тогда общее количество возможных

компаний равно сумме

Согласно формуле (1.8), доказанной в предыдущем параграфе,

С+С+...+ СЛ"=2Л,

при п = 10 получаем

Гх 4- Г2 4- 4- Г1'0 = 910— Г"

Так как С10°= 1, то общее число компаний и соответственно количество

дней, в которые эти компании могут быть приглашены, равно

210- 1 = 1023.

Пример 8. Сколькими способами 15 одинаковых шаров можно

разложить по 5 различным ящикам при условии, что ни один из ящиков не

окажется пустым?

Решение. Расположим шары в ряд (рис. 5).

Так как шары одинаковы, то их порядок в данном ряду не имеет

значения, а так как ящики различны, то пронумеруем их от одного до пяти.

Данное множество шаров разобьем на пять подмножеств. На рис. 5

разбиение осуществляется с помощью перегородок (вертикальных черточек):

шары, расположенные до первой перегородки, попадают в первый ящик,

от первой до второй перегородки — во второй ящик и т. д. Таким образом,

количество способов разложить шары равно количеству способов

расставить перегородки. Как легко заметить, для разбиения множества шаров на

пять подмножеств перегородок требуется всего четыре (на одну меньше

количества ящиков). И эти четыре перегородки должны быть расставлены

по 14 позициям (на рис. 5 место перегородок — пространство между

шарами). Итак, 4 перегородки можно расставить по 14 позициям C,J

способами.

°14 4!Ш! 4! ШЩ'

Таким образом, существует 1001 способ разложить 15 одинаковых

шаров по 5 различным ящикам, причем ни один из ящиков не окажется

пустым.

Замечание. Рассматривая в примере 8 п одинаковых шаров и т {т <п)

различных ящиков, в ответе аналогично получим С'"1Х способов.

29

1.6. Вероятность суммы событий. Противоположные события

Поскольку над случайными событиями возможны арифметические

операции сложения и умножения, то представляется разумным исследовать

вероятности, связанные с этими действиями. В частности, справедливо

следующее утверждение.

Теорема сложения. По отношению к любому испытанию и для любых

случайных событий А и В имеет место равенство:

Р(А + В) = Р{А) + Р(В) - Р(АВ). (1.10)

Доказательство. Пусть 2?„ Е2, ..., Е„ — полная система элементарных

событий. В зависимости от благоприятствования или неблагоприятствования

событиям А и В, разобьем систему на непересекающиеся группы. Не теряя

общности из-за нумерации, можно считать, что:

a) первые к событий Ех, ..., Ек благоприятствуют и событию А, и

событию В;

b) следующие г событий Ек+Х, ..., Ек+Г благоприятствуют событию А и не

благоприятствуют событию В;

c) следующие s событий £*+,+,, ..., Ek+r+s не благоприятствуют событию А

и благоприятствуют событию В;

d) остальные события Ek+I+S+1, ..., Еп не благоприятствуют ни событию А,

ни событию В.

Найдем все вероятности, представленные в (1.10):

Р(А) = £iT, P(B) = £±^,

п п

Р(АВ) = -, Р(А+В) = k+r + s

п п

(напомним, что благоприятствующими для произведения АВ являются

события, благоприятствующие и событию А, и событию В, а

благоприятствующими для суммы А + В являются события, благоприятствующие либо

А, либо В, либо и тому и другому).

Проверим справедливость равенства (1.10), используя найденные

вероятности:

Р(А) + Р(В)- Р(АВ)= k±I+!i±l-k = k + r+s = Р(А + Ву

п п п п

Утверждение доказано.

Следствие 1. Если А и В — несовместные случайные события, то из

теоремы сложения следует

Р(А + В) = Р{А) + Р(В). (1.11)

Формула (1.11) получается из формулы (1.10), так как для несовместных

событий А и В имеем Р(АВ) = P(V) = 0.

Замечание. Аналогичная формула справедлива и для суммы п попарно

несовместных событий (л > 2).

30

Следствие 2. Для трех случайных событий А, В, С теорема сложения

имеет вид:

Р(А+В+С) = Р(А) + Р(В) + Р(С) -

- Р{АВ) - Р(АС) - Р(ВС) + Р(АВС). (1.12)

Формула (1.12) получается неоднократным применением теоремы

сложения для двух слагаемых:

Р(А + В + С) = Р((А + В) + С) = Р(А + В) + Р(С) - Р((А + В)С) =

= Р(А) + Р(В)~ Р(АВ) + Р(С) - Р(АС+ ВС) = Р(А) + Р(В) +

+ Р(С) - Р{АВ) - [Р(АС) + Р(ВС) - Р(АСВС)\.

Учитывая в последнем слагаемом свойство С' С= Си, следовательно,

АСВС = АВСС = ABC, раскрывая квадратные скобки, приходим к формуле

(1.12).

Для иллюстрации применения формулы рассмотрим пример.

Пример. На стеллаже библиотеки в случайном порядке расставлены 15

учебников. Из них 5 учебников по медицине и 10 по биологии.

Библиотекарь наудачу берет 3 книги. Найти вероятность, что хотя бы один из

взятых учебников по медицине.

Решение. Обозначим искомое случайное событие символом А. Событие

А — сложное событие, которое происходит, если произойдет одно из

следующих событий: Ах — из трех выбранных учебников один по медицине и,

соответственно, два по биологии; А2 — из трех выбранных учебников два

по медицине и соответственно один по биологии; Аг — из трех выбранных

учебников все три по медицине. Таким образом, случайное событие А

(хотя бы один учебник из трех выбранных — по медицине) происходит, если

осуществляется либо Аи либо А2, либо Ау Заметим, что других событий,

благоприятствующих А, кроме Ах, А2, Аг, нет, т. е. А = Ах + А2 + Аг, и задача

сводится к нахождению вероятности суммы трех случайных событий:

Р(А) = Р(А{ + А2 + Аг).

Привлекаем формулу (1.12). Однако в нашем примере, как легко

заметить, все события-слагаемые Ах, А2, Аг попарно несовместны.

Действительно, не могут осуществляться одновременно, например, Ах (ровно одна

книга из трех по медицине) и А2 (ровно две книги из трех по медицине).

Поэтому все произведения АХА2, АхАг, А2Аг и АхА2Аг являются событиями

невозможными, и их вероятности, естественно, равны нулю. Тогда

формула (1.12) приобретает простой вид:

Р{А) = Р(АХ +А2 + А,) = Р(АХ) + Р(А2) + Р(А3).

Найдем вероятности, записанные в правой части равенства, используя

классическое определение вероятности и посчитав количество возможных

комбинаций. Извлечь три книги из 15 возможно С]5 способами. Заметим,

что 15 учебников состоят из двух множеств в 5 и 10 элементов.

Осуществление события Ах означает, что один из учебников извлечен из множества

в 5 элементов (что возможно С\ способами), а два учебника извлечены из

множества в 10 элементов (что возможно С2Х0 способами). Применив

правило умножения, получаем по классическому определению:

31

P(A \ = С^С?о = 5!10!3!12! = 45

y x) c\5 1!4!2!8!15! 9Г

Аналогично находим:

C]C\0 _ 5!10!3!12! _ 20

P(A2) =

PW =

C]5 2!3!1!9!15! 9V

_ С]С°10 = 5!3!12! = _2_

C\ 3!2!15! 91"

67

Тогда искомая вероятность Р{А) = —.

Приведенный пример показывает, как непосредственно можно

использовать теорему о вероятности суммы случайных событий.

Введем новое понятие: случайное событие, противоположное данному.

Пусть имеется некоторое случайное событие А. Рассмотрим событие,

которое дополняет А_до достоверного события. Обозначим это новое

событие А. Тогда А + А = U, а также А • А = V, где U — достоверное

событие, V — невозможное событие. Последние два равенства определяют

событие А, противоположное событию А. Однако, как легко заметить, в

равенствах оба события А и А совершенно равноправны, поэтому аналогично

событие А является противоположным событию А, т. е. случайные события

А и А — противоположные события. Для вероятностей противоположных

событий справедливо следующее утверждение:

Р(А) = 1 - Р(А). (1.13)

Действительно, так как А + А= U, то Р(А + А) = P(U).

Поскольку события А и А несовместны, то, согласно _следствию 1 из

теоремы сложения и факту P(U) = 1, получаем Р(А) + Р(А) = 1, откуда и

следует формула (1.13).

Вернемся к приведенному выше примеру. Используя противоположное

событие — все три выбранных учебника по биологии — по формуле (1.13)

легко находим

Г3

10

.3

Р(А) = \-Р(А)=\-

/.(/0 = , - ]0!3!U! = ! - 24 = 67

v ; 3!7!15! 91 91

Как видим, обращение к вероятности противоположного события в

данном примере существенно облегчает вычисления.

1.7. Условная вероятность. Зависимые и независимые события

Пусть при некотором комплексе условий проводится испытание, в

результате которого могут произойти случайные события А и В с

вероятностями Р(А) и Р(В) соответственно. Например, испытание — бросание

правильной игральной кости; А — выпадение четного числа очков; В —

выпадение "шестерки". Очевидно, что Р(В) = \ безотносительно

6

32

события А. Усложним задачу: полагаем известным, что событие А

произошло, и требуется найти вероятность события В с учетом данной

информации. Условие обязательного осуществления события А означает

изменение комплекса условий, при котором проводится испытание, а это может

повлечь изменение вероятности события В. В рассмотренном примере

выпадение четного числа очков (событие А) уменьшает полную систему

элементарных событий до п, равном 3: выпадение "двойки", "четверки" и

"шестерки". Тогда вероятность события В при условии, что событие А

произошло, равна 1/3, т. е. в нашем примере вероятность события В различна

в зависимости от того, учитывается событие А или нет.

Определение. Условной вероятностью события В при гипотезе А

называется вероятность события В при условии, что событие А обязательно

происходит. Обозначим соответствующую условную вероятность Р(В\А).

Как отмечено выше, обязательное осуществление случайного события А

связано с изменением комплекса условий, при котором производится

испытание. И тогда при измененном комплексе условий относительно

события В возможны два варианта: вероятность события В сохраняет прежнее

значение или изменяется.

Определение. Событие В называется независимым от события А, если

условная вероятность события В при гипотезе А равна безусловной

вероятности события В:

Р(В\А) = Р(В).

Определение. Событие В называется зависимым от события А, если

Р{В\А)*Р(В).

Далее, используя понятие условной вероятности, сформулируем

теорему умножения.

Теорема. По отношению к любому испытанию и для любых двух

случайных событий А и В справедливы соотношения

Р(АВ) = Р(А)-Р(В\А), (1.14)

Р(АВ) = Р(В)-Р(А\В).

Доказательство. Как легко заметить, вторая формула (1.14) получается

из первой, если А и В поменять местами. Поэтому достаточно доказать

лишь одно равенство, например первое.

Пусть Ех, Е^, ..., Е„ — полная система элементарных событий. Среди

этих п событий выделим следующие группы:

первые к событий 2?,,..., Ек благоприятствуют осуществлению и события

А и события В (т. е. АВ);

следующие г событий, Ек+Х, ..., Ек+п благоприятствуют осуществлению

события А и не благоприятствуют осуществлению события В (т. е. АВ);

следующие s событий, Ек+Г+Х, ..., Ek+I+S, не благоприятствуют

осуществлению события А и благоприятствуют осуществлению события В (т. е. АВ);

оставшиеся события, Ек+1^.^х, ..., Еп-не благоприятствуют осуществлению

ни события А, ни события В (т. е. АВ).

Используя классическое определение, найдем вероятности,

используемые в первой из формул (1.14):

Р(А) = £±-г, Р{АВ) = *, Р{В\А) = JL

П И К -г Г

3 — 3529

33

Проверяем справедливость формулы:

Р(А)-Р(В\А) = £±± • т^- = - = Р(АВ).

п к + г п

Теорема доказана.

Приведем важные следствия из теоремы умножения.

Следствие 1. По отношения к любому испытанию и для любых

случайных событий А и В с ненулевыми вероятностями Р(А) и Р(В) условные

вероятности можно вычислить по формулам:

Р{В\А) = ЕпВ' (115)

v ' ' Р(В)

Формулы (1.15) элементарно следуют из (1.14).

Следствие 2. В любом испытании, если событие В не зависит от

события А, то и событие А не зависит от события В при условии, что

Р(АВ)*0.

Действительно, используя оба равенства (1.14), получаем

Р(АВ) = Р(А)-Р(В\А) = Р(В)-Р(А\В).

Предполагая независимость В от А, т. е. Р(В\А) = Р(В), последнее из

равенств получаем в виде

Р{А)-Р{В) = Р(В)-Р(А\В).

Отсюда при Р(В) Ф О следует равенство Р(А) = Р(А\В), а это и

означает, что событие А не зависит от события В. Следствие 2 доказано.

Исходя из следствия 2, в дальнейшем, говоря о независимости двух

событий, всегда будем иметь в виду взаимную независимость как события А

от события В, так и события В от события А.

Следствие 3. Для независимых случайных событий А и В справедливо

равенство

Р(АВ) = Р{А)-Р{В). (1.16)

Равенство (1.16) следует из первой формулы (1.14) при использовании

равенства Р{В\А) = Р{В), справедливого для независимых событий, либо

из второй формулы (1.14) при использовании равенства Р(А\В) = Р(А).

Следствие 4. Для трех случайных событий А, В, С из теоремы

умножения следует формула

Р{АВС) = Р{А)- Р(В\А)- Р(С\АВ). (1.17)

Действительно, рассматривая ABC как произведение двух

сомножителей, АВС—{АВ)-С, согласно теореме умножения, получаем

Р(АВС) = Р(АВ)- Р(С\АВ) и далее Р{АВ) представляем по первой из

формул (1.14).

Следствие 4 доказано.

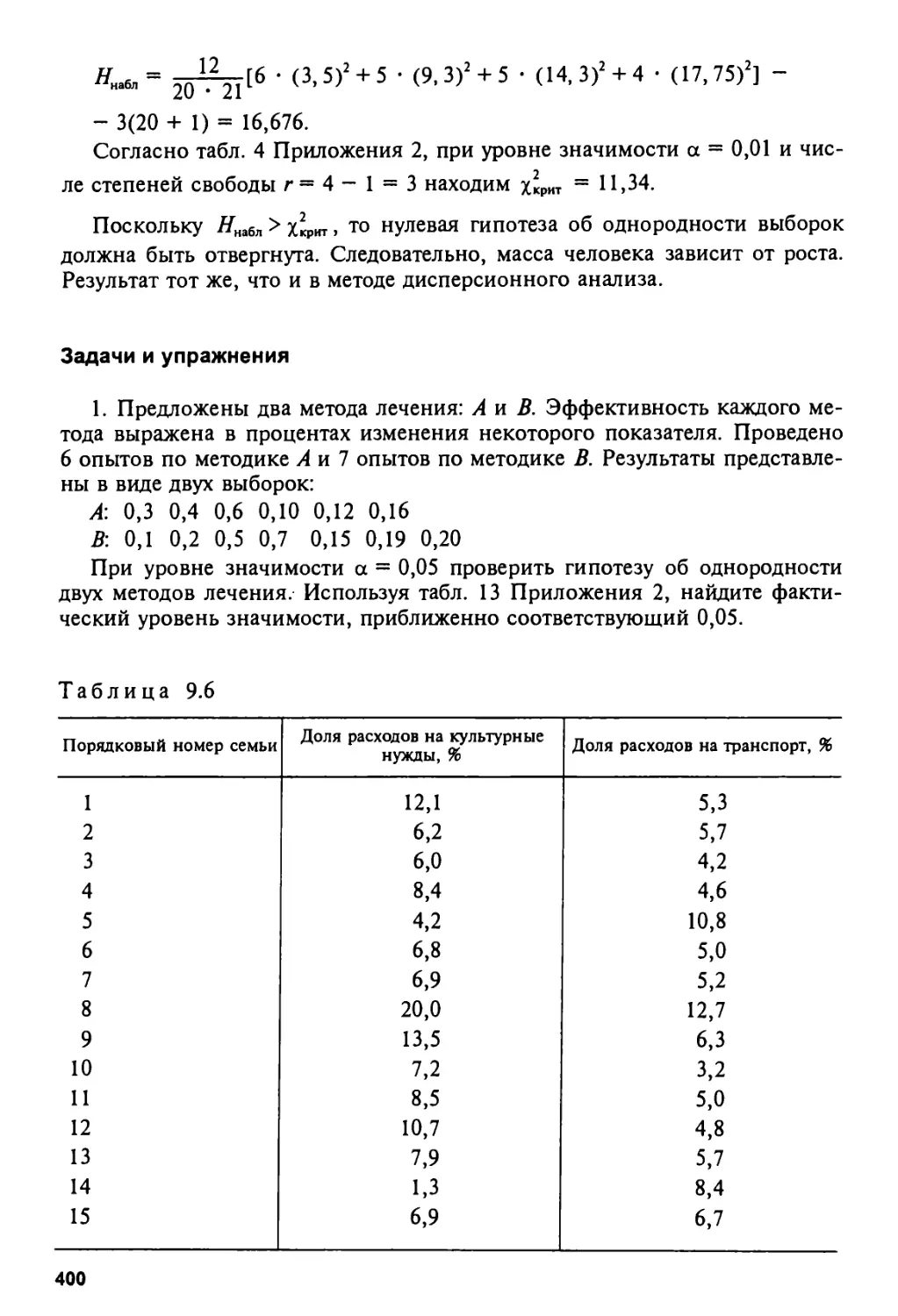

Выше было определено понятие независимости для двух случайных