Автор: Маркс Р. Дембски У. Эверт У.

Теги: программирование на эвм компьютерные программы вычислительные машины и устройства дискретного действия (цифровые вычислительные машины и устройства) информатика

ISBN: 978-5-97060-725-1

Год: 2020

Текст

California State University Channel Islands, USA

Данная книга рассказывает о том, как ученые соединили методы моделирования сложных процессов и теорию информации, благодаря чему

стало возможно измерить сложность всех явлений мироздания в битах.

Построенная на основе серии рецензируемых статей, книга написана

языком, легко понятным для читателей со знанием математики на уровне

средней школы.

An Introduction to the

Analysis of Algorithms

Если читатель стремится бегло охватить тему или не интересуется математическими подробностями, он может пропустить разделы, отмеченные

специальным значком, и все равно испытает восторг от знакомства с новой

захватывающей моделью информации о природе.

Книга написана для энтузиастов в области науки, техники и математики,

заинтересованных в понимании важной и пока еще недооцененной роли

информации в теории эволюции.

3rd Edition

ISBN 978-5-97060-725-1

Интернет-магазин:

www.dmkpress.com

NEW JERSEY • LONDON • SINGAPORE • BEIJING • SHANGHAI • HONG KONG • TAIPEI • CHENNAI • TOKYO

Оптовая продажа:

КТК “Галактика”

books@alians-kniga.ru

www.дмк.рф

9 785970 607251

Введение в эволюционную информатику

Наука добилась больших успехов в моделировании пространства, времени,

массы и энергии, но слишком мало сделала для того, чтобы создать модель

информации, заполняющей нашу

Вселенную.

Michael

Soltys

Роберт Маркс

Уильям Дембски

Уинстон Эверт

Введение

в эволюционную

информатику

Роберт Маркс, Уильям Дембски, Уинстон Эверт

Введение

в эволюционную информатику

I N T RO D U CT I O N TO

EVOLUTIONARY

INFORMATICS

Robert J Marks II

Baylor University, USA

William A Dembski

Evolutionary Informatics Lab, USA

Winston Ewert

Evolutionary Informatics Lab, USA

NEW JERSEY • LONDON • SINGAPORE • BEIJING • SHANGHAI • HONG KONG • TAIPEI • CHENNAI • TOKYO

ВВЕДЕНИЕ

В ЭВОЛЮЦИОННУЮ

ИНФОРМАТИКУ

Роберт Маркс

Университет Бэйлор, США

Уильям Дембски

Лаборатория эволюционной информатики, США

Уинстон Эверт

Лаборатория эволюционной информатики, США

Москва, 2020

УДК 004.421, 57.08

ББК 32.972, 28.0

М25

Маркс Р., Дембски У., Эверт У.

М25 Введение в эволюционную информатику / пер. с анг. В. С. Яценкова. – М.:

ДМК Пресс, 2020. – 276 с.: ил.

ISBN 978-5-97060-725-1

Наука добилась больших успехов в моделировании пространства, времени, массы

и энергии, но слишком мало сделала для того, чтобы создать модель информации,

заполняющей нашу Вселенную.

Данная книга рассказывает о том, как ученые соединили методы моделирования

сложных процессов и теорию информации, благодаря чему стало возможно измерить

сложность всех явлений мироздания в битах. Построенная на основе серии рецензируемых статей, книга написана языком, легко понятным для читателей со знанием

математики на уровне средней школы.

Если читатель стремится бегло охватить тему или не интересуется математическими подробностями, он может пропустить разделы, отмеченные специальным значком, – и все равно испытает восторг от знакомства с новой захватывающей моделью

информации о природе.

Издание написано для энтузиастов в области науки, техники и математики, заинтересованных в понимании важной и пока еще недооцененной роли информации

в теории эволюции.

УДК 004.421, 57.08

ББК 32.972, 28.0

Authorized Russian translation of the English edition of Introduction to Evolutionary

Informatics ISBN 9789813142145 © 2017 by World Scientific Publishing Co. Pte. Ltd.

This translation is published and sold by permission of Packt Publishing, which owns or

controls all rights to publish and sell the same.

Все права защищены. Любая часть этой книги не может быть воспроизведена в какой бы то ни было форме и какими бы то ни было средствами без письменного разрешения

владельцев авторских прав.

ISBN 978-9-8131-4214-5 (анг.)

ISBN 978-5-97060-725-1 (рус.)

© 2017 by World Scientific Publishing Co. Pte. Ltd.

© Оформление, издание, перевод, ДМК Пресс, 2020

Содержание

Вступительное слово от издательства. ....................................................9

Предисловие.....................................................................................................10

Об авторах.........................................................................................................19

Глава 1. Введение............................................................................................21

1.1. Королева ученых и инженеров.......................................................................22

1.2. Наука и модели................................................................................................23

1.2.1. Компьютерные модели............................................................................24

1.2.2. Невероятное и невозможное...................................................................24

Источники..............................................................................................................25

Глава 2. Информация: что это такое?. ....................................................27

2.1. Определение информации.............................................................................27

2.2. Измерение информации................................................................................29

2.2.1. Cложность по KCS.....................................................................................30

2.2.2. Информация Шеннона............................................................................37

2.3. Заключение......................................................................................................44

Источники..............................................................................................................44

Глава 3. Эволюционный поиск и требования к информации.......47

3.1. Эволюция как поиск.......................................................................................47

3.1.1. WD-40TM и Formula 409TM. ........................................................................48

3.1.2. Тесла, Эдисон и знания в предметной области......................................48

3.2. Инженерная разработка с помощью компьютера........................................49

3.3. Разработка рецепта вкусных блинов.............................................................50

3.3.1. Поиск хорошего блина № 1.....................................................................50

3.3.2. Поиск хорошего блина № 2: время приготовления плюс

настройка оборудования...................................................................................53

3.3.3. Поиск хорошего блина № 3: больше переменных параметров

рецепта...............................................................................................................53

3.3.4. Поиск хорошего блина № 4: имитация блинов на компьютере

с искусственным языком с использованием одного агента...........................55

3.3.5. Поиск хорошего блина № 5: моделирование блинов

на компьютере с помощью эволюционного поиска.......................................57

3.4. Источники знаний..........................................................................................58

3.4.1. Проектирование антенн с использованием эволюционных

вычислений........................................................................................................60

6

Содержание

3.5. Проклятие размерности и потребность в знаниях.......................................62

3.5.1. Поможет ли Мур? Как насчет Гровера?...................................................63

3.6. Неявные цели..................................................................................................64

3.7. Оптимальная неоптимальность.....................................................................67

3.7.1. Потеря функции.......................................................................................67

3.7.2. Оптимизация Парето и оптимальная субоптимальность.....................68

3.7.3. Человек в цикле как фактор активной информации.............................70

3.8. Ландшафты отбора поисковых алгоритмов..................................................71

3.9. Выводы.............................................................................................................73

Источники..............................................................................................................73

Глава 4. Детерминизм в случайности. ....................................................81

4.1. Принцип равной вероятности событий........................................................83

4.1.1 «Ничто есть то, о чем мечтают скалы»....................................................83

4.1.2. Принцип недостаточного основания Бернулли (PrOIR).......................84

4.2. Потребность в шуме........................................................................................99

4.2.1. Фиксированные точки в случайных событиях.......................................99

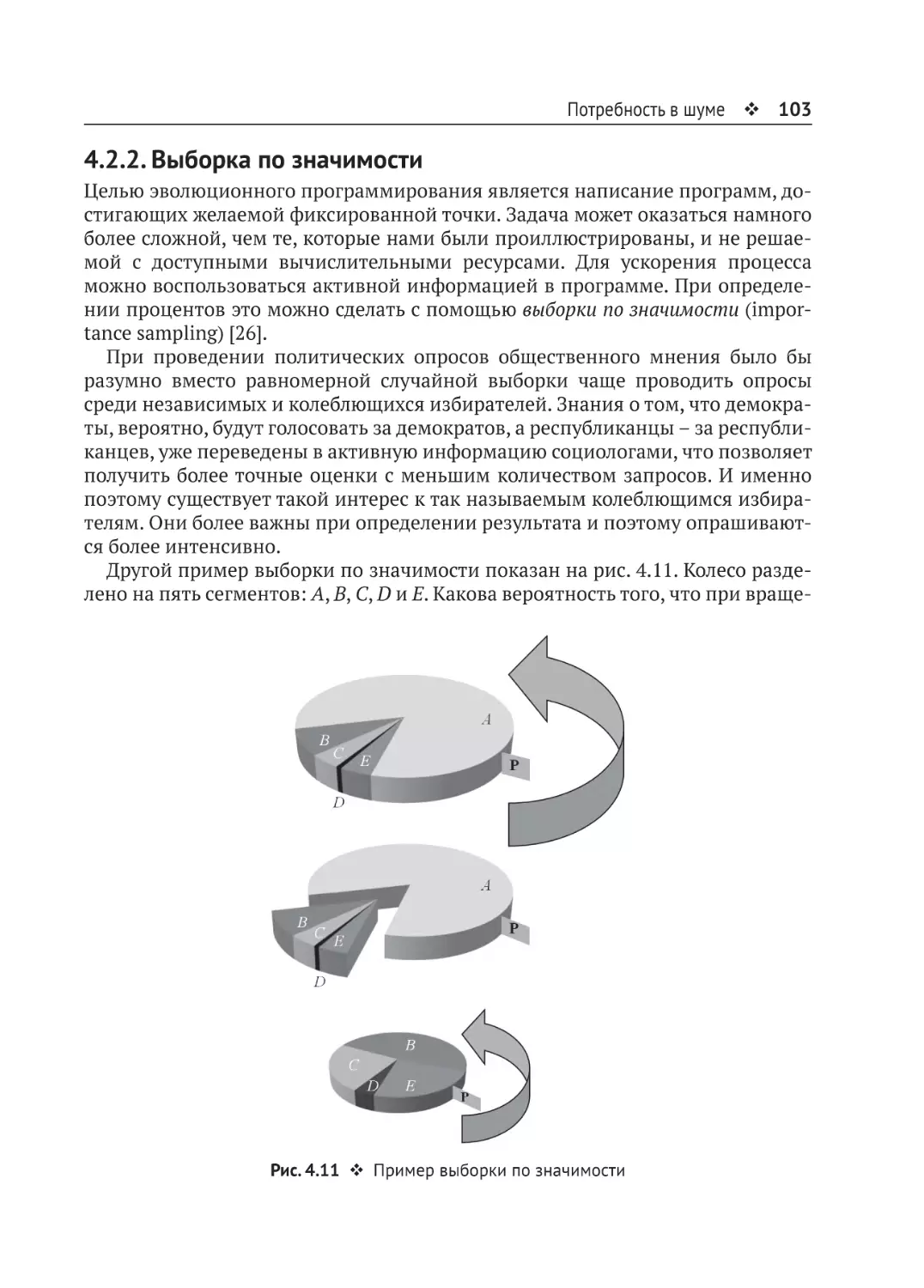

4.2.2. Выборка по значимости........................................................................103

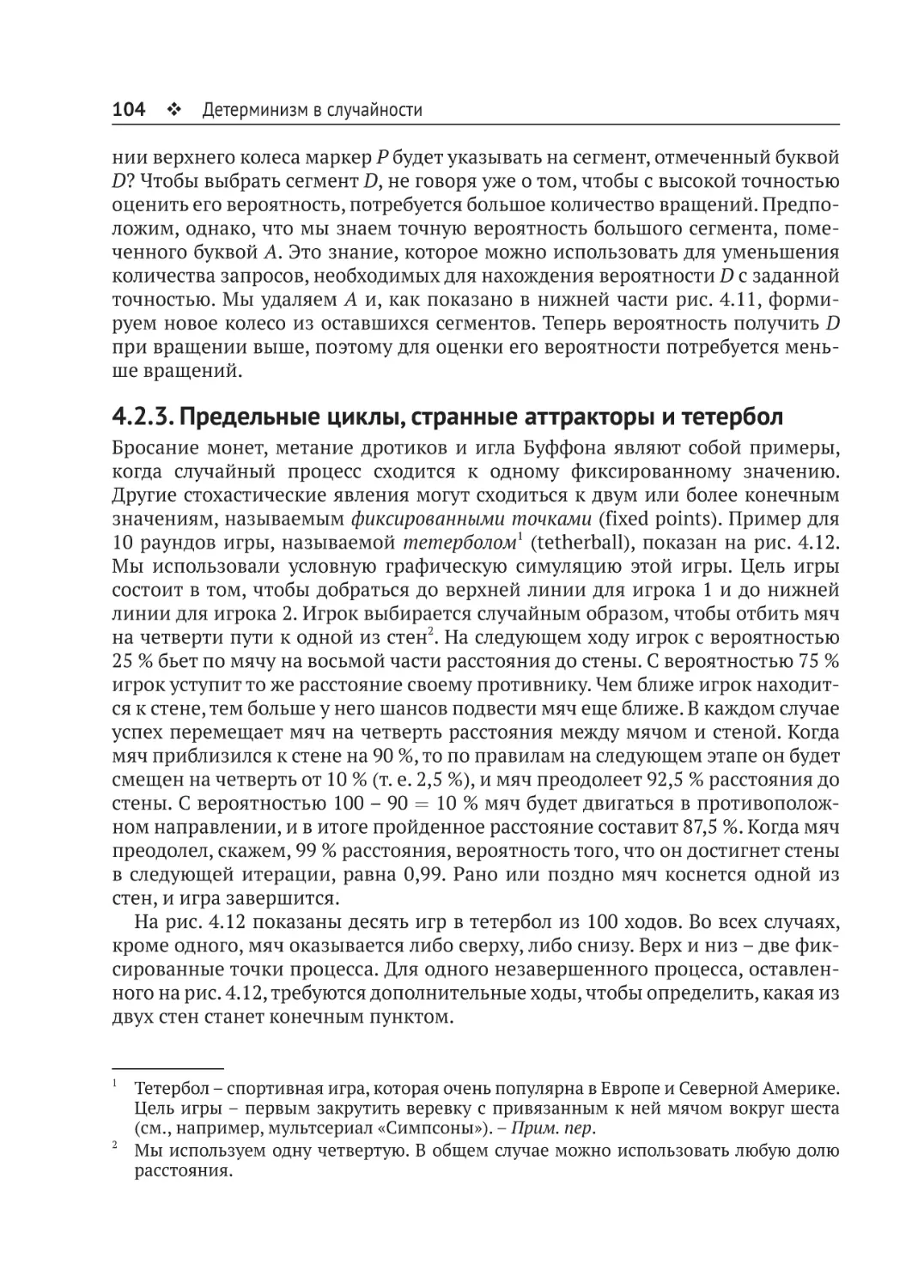

4.2.3. Предельные циклы, странные аттракторы и тетербол........................104

4.3. Потолок Бейснера.........................................................................................105

4.3.1. Tierra.......................................................................................................106

4.3.2. Край эволюции.......................................................................................109

4.4. Заключение....................................................................................................110

Источники............................................................................................................111

Глава 5. Сохранение информации в компьютерном поиске.......114

5.1. Основы...........................................................................................................114

5.2. Что такое сохранение информации?...........................................................116

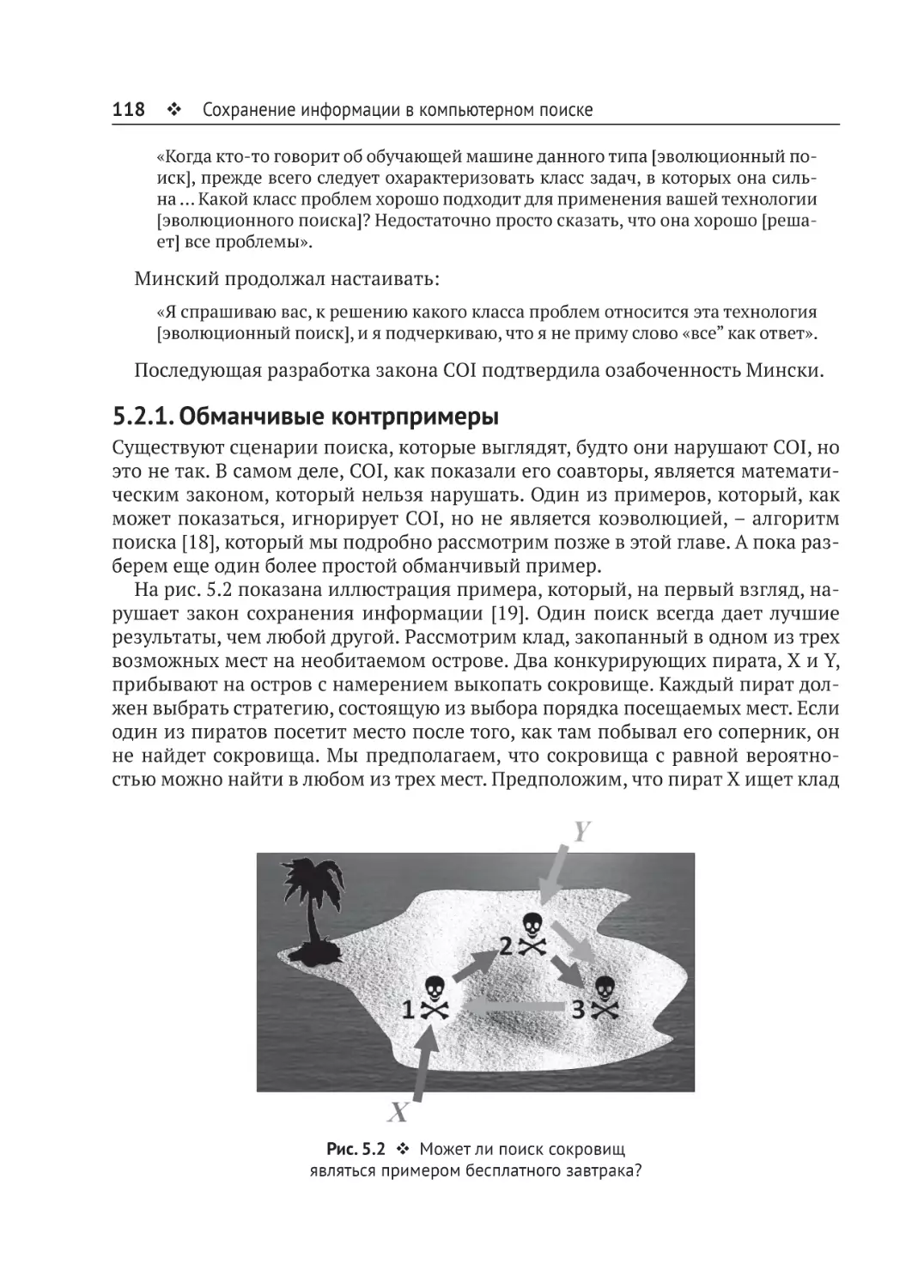

5.2.1. Обманчивые контрпримеры.................................................................118

5.2.2. Взаимосвязь между обучением и поиском..........................................120

5.2.3. Человек в цикле, вносящий активную информацию..........................125

5.3. Удивительная стоимость слепого поиска в битах.......................................128

5.3.1. Анализ.....................................................................................................128

5.3.2. Вычислительная стоимость...................................................................129

5.4. Измерение сложности поиска в битах.........................................................131

5.4.1. Эндогенная информация......................................................................131

5.4.2. Активная информация..........................................................................136

5.4.3. Извлечение активной информации из оракулов................................148

5.5. Источники информации в эволюционном поиске.....................................156

5.5.1. Популяция..............................................................................................157

5.5.2. Коэффициент мутации..........................................................................157

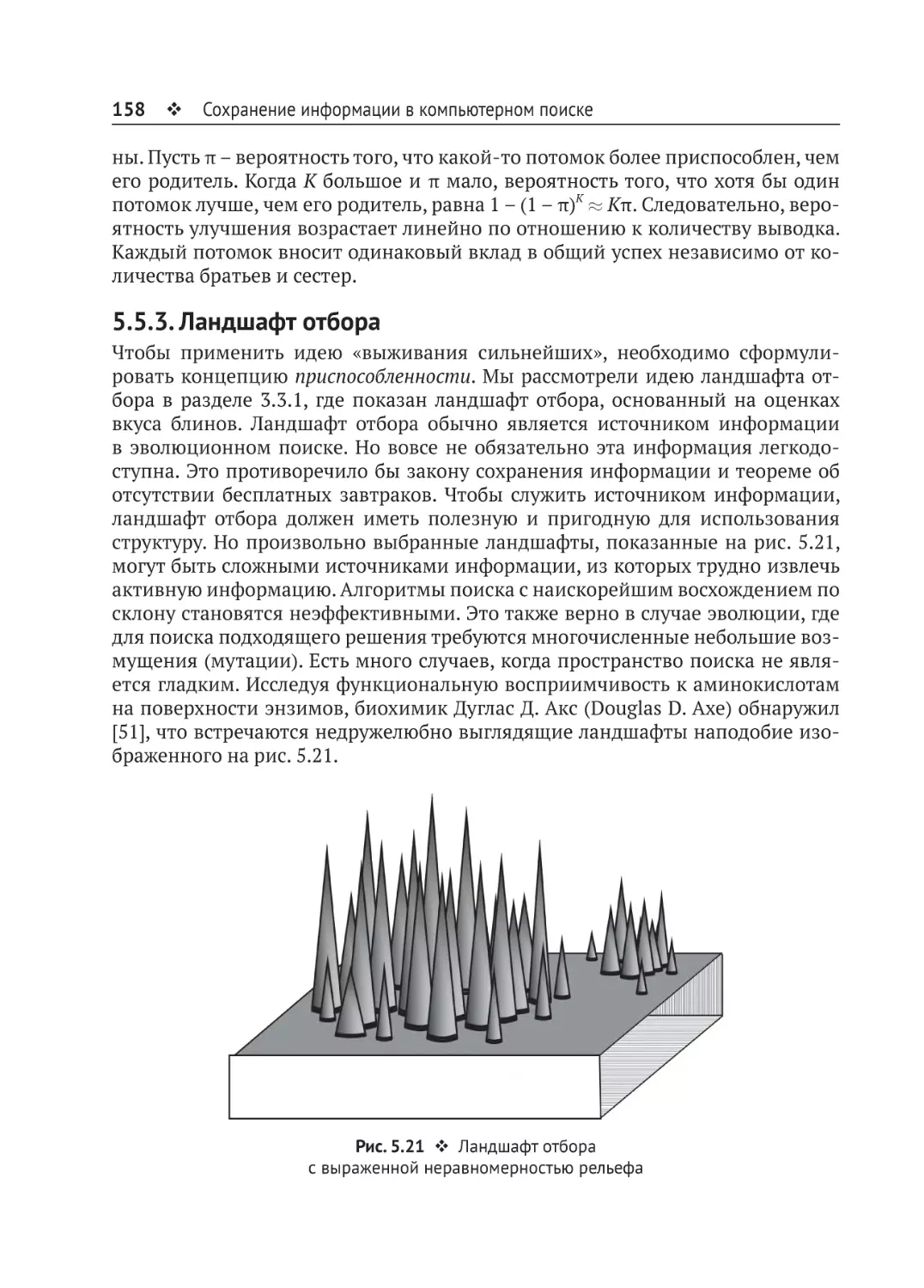

5.5.3. Ландшафт отбора...................................................................................158

5.6. Ступенчатая информация и переходная функциональная

жизнеспособность...............................................................................................160

Содержание 7

5.6.1. Детские шаги..........................................................................................162

5.6.2. Сохранение функциональности развития и неснижаемая

сложность.........................................................................................................162

5.7. Коэволюция....................................................................................................167

5.8. Поиск поиска.................................................................................................171

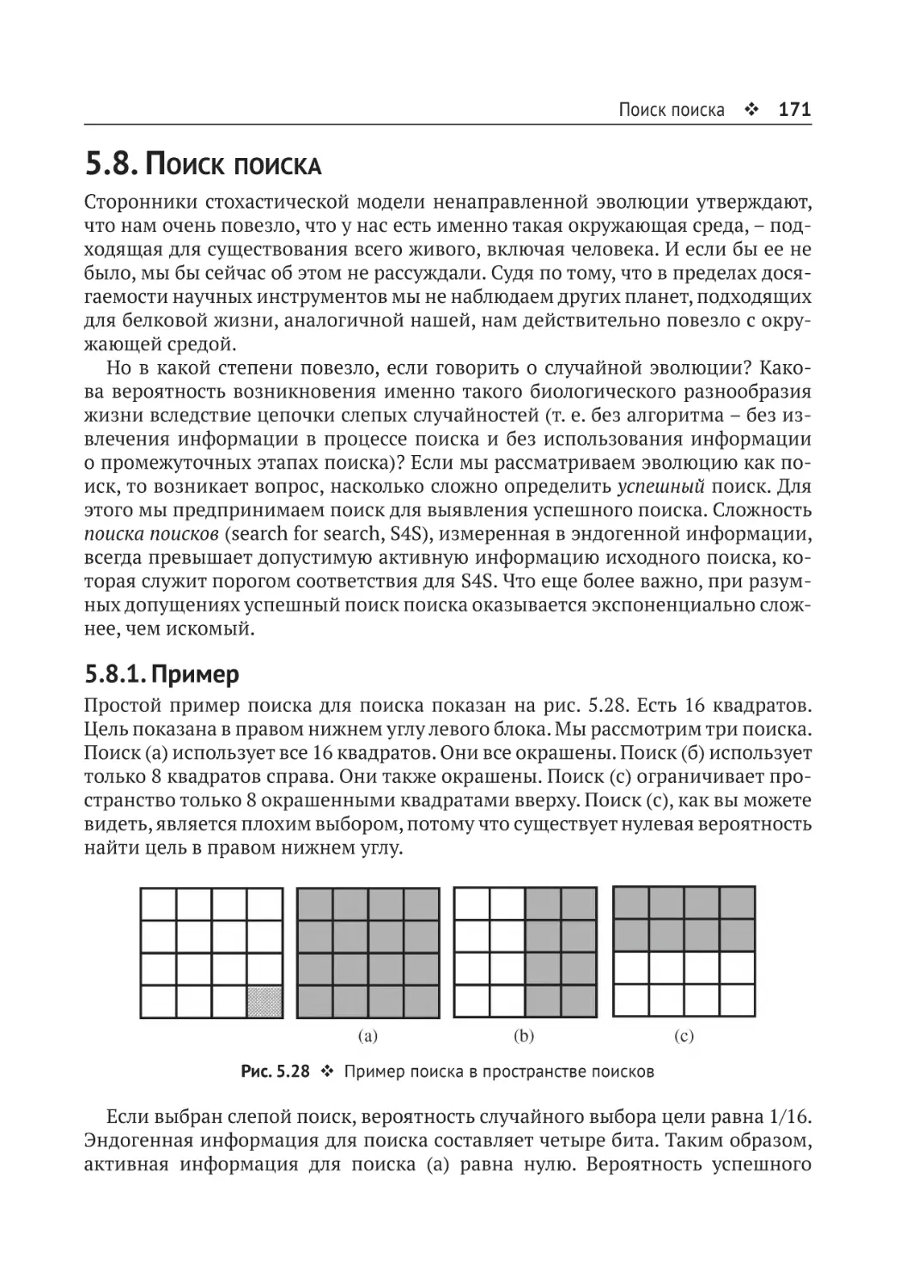

5.8.1. Пример....................................................................................................171

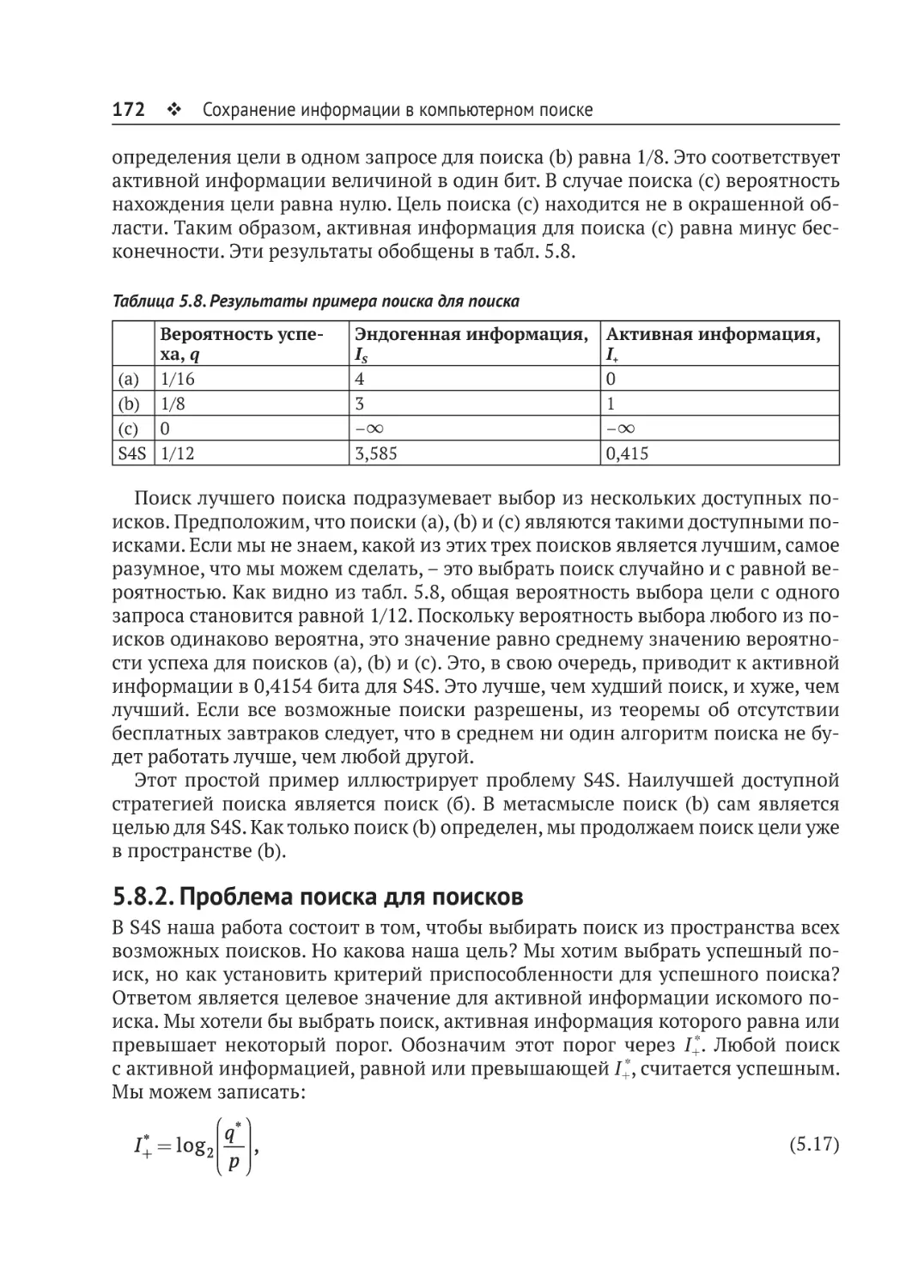

5.8.2. Проблема поиска для поисков..............................................................172

5.8.3. Математические доказательства..........................................................174

5.9. Заключение....................................................................................................179

Источники............................................................................................................179

Глава 6. Анализ моделей биологической эволюции. .....................185

6.1. EV: программная модель эволюции............................................................186

6.1.1. Структура EV...........................................................................................186

6.1.2. Устройство программы EV.....................................................................189

6.1.3. Внутренние источники информации в EV...........................................192

6.1.4. Поиск.......................................................................................................195

6.1.5. Интерфейс EV Ware................................................................................197

6.1.6. Диагноз...................................................................................................200

6.2. Avida: ступенчатый поиск и логика NAND..................................................202

6.2.1. Булева логика.........................................................................................202

6.2.2. Логика NAND..........................................................................................203

6.2.3. Организм Avida и его здоровье.............................................................208

6.2.4. Анализ Avida с точки зрения информации..........................................212

6.2.5. Наличие замысла в программе Avida...................................................221

6.2.6. Движения мертвого организма.............................................................223

6.3. Метабиология................................................................................................223

6.3.1. Проблема остановки..............................................................................225

6.3.2. Проблема поиска....................................................................................226

6.3.3. Математический базис метабиологии.................................................227

6.3.4. Ресурсы...................................................................................................231

6.4. Пора подметать грязный пол?.....................................................................232

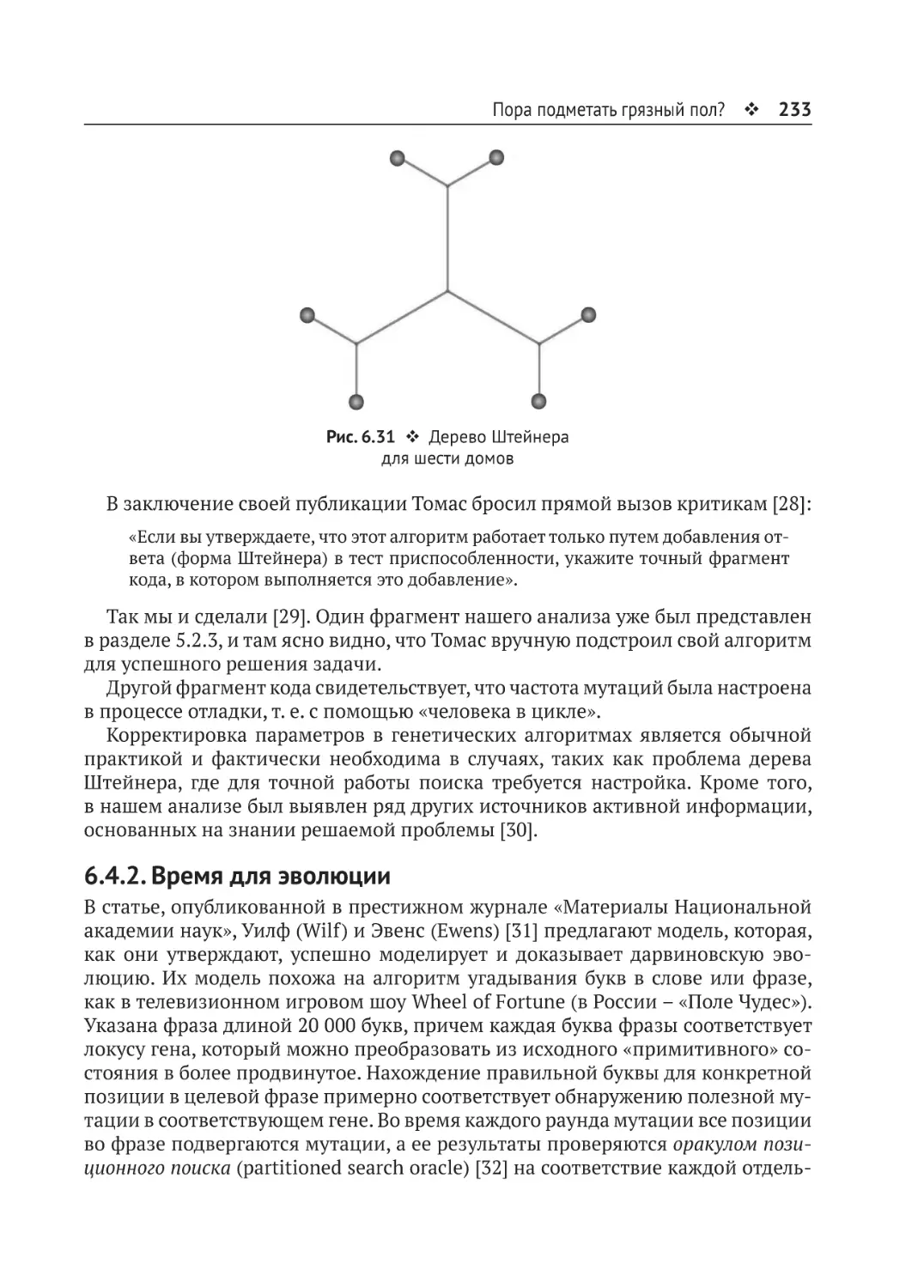

6.4.1. Доработка дерева Штейнера.................................................................232

6.4.2. Время для эволюции..............................................................................233

6.4.3. Заключение.............................................................................................234

Источники............................................................................................................234

Глава 7. Измерение смысла и алгоритмическая

заданная сложность.....................................................................................240

7.1. Значимость информации.............................................................................240

7.2. Условная сложность KCS................................................................................242

7.3. Определение алгоритмической заданной сложности (ASC)......................243

7.3.1. Высокая ASC и низкая вероятность.......................................................245

8

Содержание

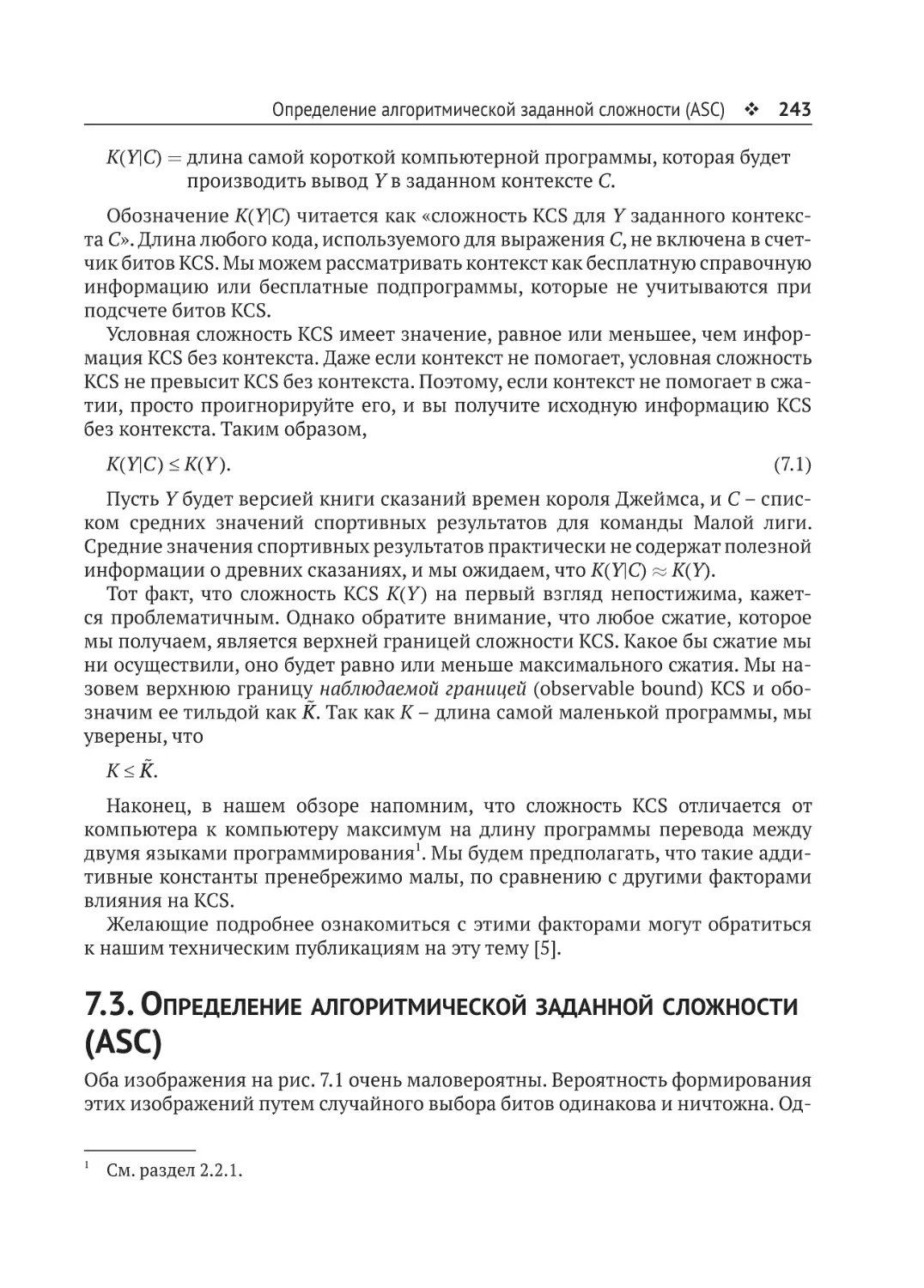

7.4. Примеры ASC.................................................................................................246

7.4.1. Расширенные буквенно-цифровые символы.......................................246

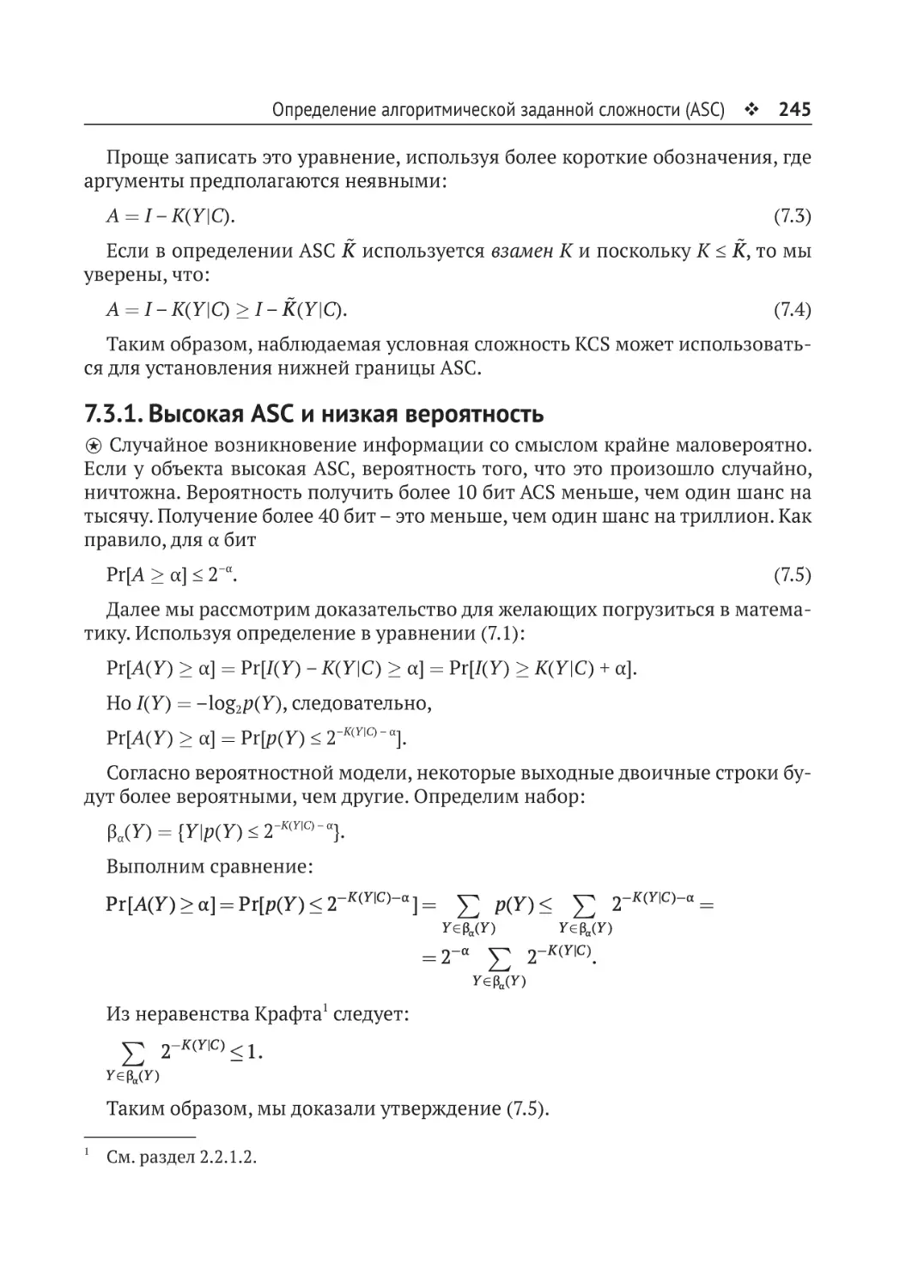

7.4.2. Игра в покер............................................................................................249

7.4.3. Снежинки................................................................................................250

7.4.4. ASC в игре «Жизнь»................................................................................252

7.5. Смысл в глазах смотрящего..........................................................................263

Источники............................................................................................................264

Глава 8. Разум и искусственный интеллект........................................266

8.1. Тьюринг и Лавлейс: сильный и слабый интеллект.....................................267

8.1.1. Ошибка Тьюринга..................................................................................267

8.1.2. Тест Лавлейс...........................................................................................269

8.1.3. Озарение гения......................................................................................270

8.2. Интеллект и непознаваемое.........................................................................271

8.3. Заключение....................................................................................................272

Источники............................................................................................................272

Предметный указатель...............................................................................274

Вступительное слово

от издательства

Отзывы и пожелания

Мы всегда рады отзывам наших читателей. Расскажите нам, что вы думаете об

этой книге – что понравилось или, может быть, не понравилось. Отзывы важны

для нас, чтобы выпускать книги, которые будут для вас максимально полезны.

Вы можете написать отзыв на нашем сайте www.dmkpress.com, зайдя на

страницу книги и оставив комментарий в разделе «Отзывы и рецензии». Также можно послать письмо главному редактору по адресу dmkpress@gmail.com;

при этом укажите название книги в теме письма.

Если вы являетесь экспертом в какой-либо области и заинтересованы в написании новой книги, заполните форму на нашем сайте по адресу http://dmk

press.com/authors/publish_book/ или напишите в издательство по адресу dmk

press@gmail.com.

Список опечаток

Хотя мы приняли все возможные меры для того, чтобы обеспечить высокое

качество наших текстов, ошибки все равно случаются. Если вы найдете ошибку

в одной из наших книг – возможно, ошибку в основном тексте или программном коде, – мы будем очень благодарны, если вы сообщите нам о ней. Сделав

это, вы избавите других читателей от недопонимания и поможете нам улучшить последующие издания этой книги.

Если вы найдете какие-либо ошибки в коде, пожалуйста, сообщите о них

главному редактору по адресу dmkpress@gmail.com, и мы исправим это в следующих тиражах.

Нарушение авторских прав

Пиратство в интернете по-прежнему остается насущной проблемой. Издательства «ДМК Пресс» и World Scientific очень серьезно относятся к вопросам

защиты авторских прав и лицензирования. Если вы столкнетесь в интернете

с незаконной публикацией какой-либо из наших книг, пожалуйста, пришлите

нам ссылку на интернет-ресурс, чтобы мы могли применить санкции.

Ссылку на подозрительные материалы можно прислать по адресу электронной почты dmkpress@gmail.com.

Мы высоко ценим любую помощь по защите наших авторов, благодаря которой мы можем предоставлять вам качественные материалы.

Предисловие

Наука добилась больших успехов в моделировании пространства, времени,

массы и энергии, но слишком мало сделала, для того чтобы создать модель

информации, заполняющей нашу Вселенную. Сегодня теория информации

используется для измерения емкости диска Blu-ray или для описания пропускной способности соединения Wi-Fi. Тем не менее наука не рассматривает

трудности, связанные с созданием содержимого Blu-ray и смыслом данных, передаваемых через соединение Wi-Fi. Новые достижения теории информации

позволяют оценить роль информации в эволюционных процессах и под новым

углом взглянуть на само понятие информации и ее роль в картине мироздания.

В самом деле, все современные модели требуют для работы информацию от

внешнего источника. Иными словами, все современные эволюционные модели просто не работают без подключения к внешнему источнику информации.

В объяснении основ захватывающей теории информации на доступном уровне

и заключается назначение книги «Введение в эволюционную информатику».

Первоисточники

Содержание этой монографии вытекает из оригинальных работ одного из ваших скромных соавторов, Уильяма А. Дембски (William A. Dembski) [1], и последующих отредактированных трудов [2]. Авторы написали множество статей

и глав книг, в которых содержится основополагающий материал для этой монографии [3]. Ссылки на многие из этих документов доступны на нашем сайте EvoInfo.org. В данной монографии мы приводим рисунки и текст из этих

работ, иногда дословно. Во всех случаях мы старались дать прямую ссылку на

источник, но, возможно, что-то упустили.

Вне всяких сомнений, у материала этой монографии прочная основа. Цитируемые статьи тем не менее написаны на уровне, который понятен только

фанатичным ученым. Данная монография служит двум целям. Во-первых, это

объяснение эволюционной информатики на уровне, доступном для хорошо

эрудированного читателя. Во-вторых, мы убеждены, что данная работа достаточно полно раскрывает различные точки зрения на теорию эволюционного

моделирования.

Математика и символ ⍟

Хотя в этой книге мы попытались свести к минимуму обращения к математике, иногда без нее не обойтись. В таких случаях мы выделяем математический

материал символом ⍟ и даем максимально четкое объяснение основополагающих рассуждений.

Краткое содержание глав 11

Математический материал может быть понят с начальным знанием:

простых логарифмов;

элементарной теории вероятностей;

элементарной статистики, такой как средние значения (или среднее по

выборке);

представления чисел в двоичном формате (по основанию 2);

простых операций булевой алгебры, таких как И (AND), ИЛИ (OR), НЕ

(NOT), И-НЕ (NAND), ИЛИ-НЕ (NOR), ИСКЛЮЧАЮЩЕЕ ИЛИ (XOR) и т. д.

Чтобы помочь тем, кто хочет быстрее прочитать книгу или не интересуется

математическими подробностями, мы пометили символом ⍟ разделы, которые можно пропустить. Некоторые математические дополнения даны в снос

ках и также помечены символом ⍟.

Ссылки и сноски

Как правило, в конце глав перечислены источники и дополнительная литература, в то время как в сносках содержатся пояснения и дополнения к материалу

главы. Ссылки на источники обозначены числом в квадратных скобках, сноски

обозначены надстрочным числом. При быстром или обзорном чтении сноски

можно пропустить.

Краткое содержание глав

Глава 1. Введение

Ученые и философы часто возводят теорию или идеологию на трон, словно королеву, а инженеры заставляют королеву сойти с трона и вымыть пол. И если

она не работает, ее прогоняют прочь.

Ученые надеялись, что быстрые компьютеры позволят построить универсальную модель ненаправленной эволюции, основанную исключительно на

случайных мутациях. Однако пока это не удалось. Если опираться только на

теорию вероятностей, вы непременно сталкиваетесь с законом Бореля (Borel’s

law), который гласит, что события, описанные с достаточно малой (стремящейся к нулю) вероятностью, являются невозможными событиями. Например, существует ненулевая вероятность того, что вы испытаете квантовое туннелирование через стул, на котором сидите. Однако вероятность настолько мала, что

мы можем классифицировать событие как невозможное.

Глава 2. Информация: что это такое?

Информация – это не материя и не энергия. Она выступает как самостоятельный компонент природы.

Термин «информация», как правило, не очень хорошо определен, используется ли он в повседневной беседе или в журнальной статье. Теория информации Шеннона (Shannon) является, пожалуй, самой известной математической

12

Предисловие

моделью информации. Шеннон отметил очевидное: его модель информации

ограничена и не применима к широкому кругу возможных определений информации.

Теория информации Колмогорова–Хайтина–Соломонова (Kolmogorov–Chaitin–Solomonov, KCS), также известная как алгоритмическая теория информации, является еще одной популярной моделью информации. Однако и модели

Шеннона, и KCS не способны моделировать информацию в части измерения

смысла или значимости, относящихся к объекту.

Глава 3. Эволюционный поиск и требования к информации

Инженерное проектирование – это всегда итеративный поиск, основанный на

компетенции разработчика. Для создания WD-40 понадобилось 40 испытаний,

а Formula 409 потребовала 409 попыток. Так эти продукты получили числовую

часть своих названий.

Анатомия поиска иллюстрируется на примере того, как шеф-повар разрабатывает хороший рецепт блинов. Выделены важные аспекты разработки, в том

числе роль отраслевого эксперта и проклятие размерности, которое может

быстро сделать невозможным априорно-неинформированный проект.

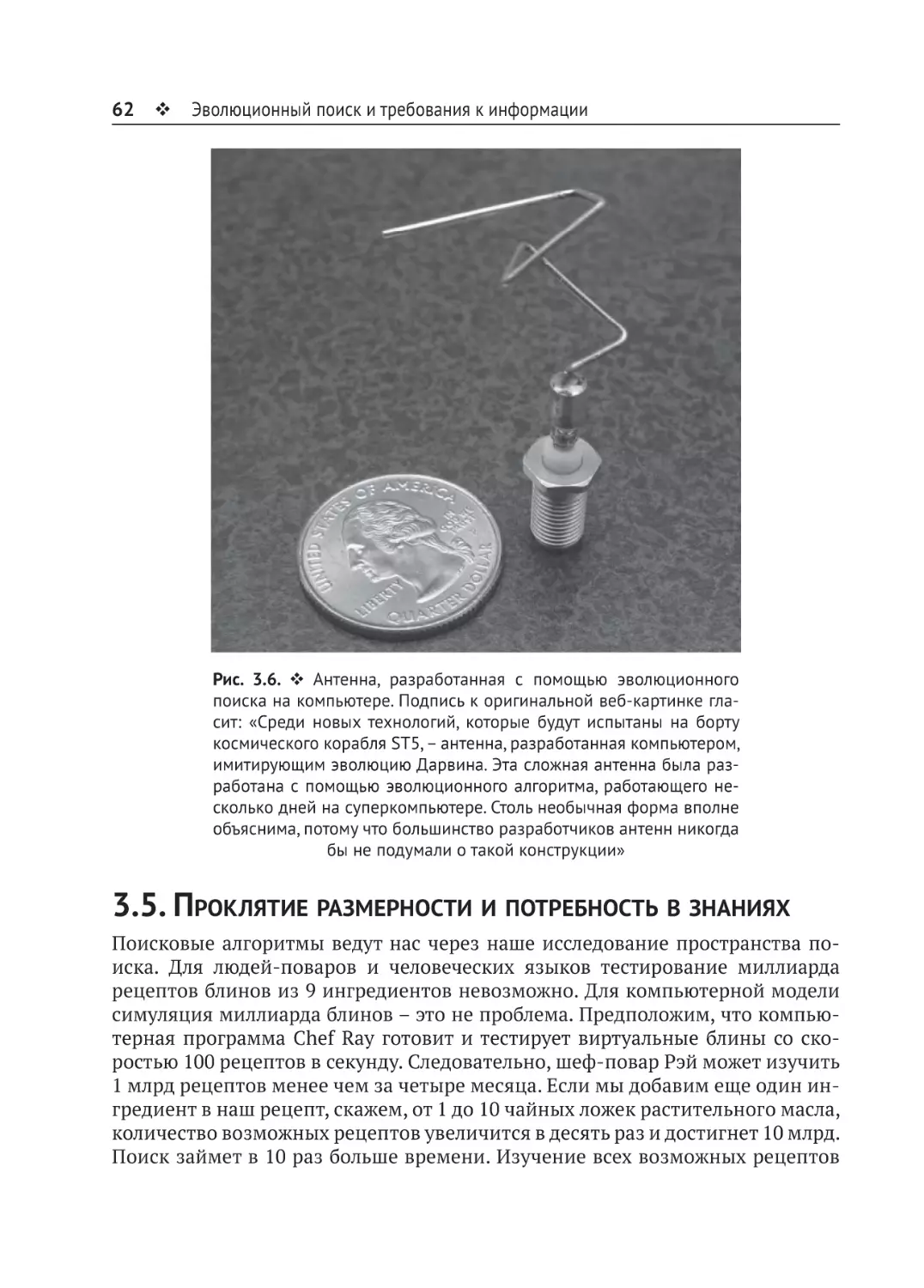

Анализ разработанной с использованием эволюционного поиска антенны

NASA показывает, что в области эволюционного проектирования накоплены

достаточно обширные познания, и проблема поиска была не такой уж сложной.

При разработке чего угодно невозможно обойтись без компромиссов. Разработка недорогого и безопасного автомобиля требует определенного баланса

критериев. Дешевые машины небезопасны, а безопасные машины недешевы. Более того, глобальная оптимальность требует частичной оптимальности

(субоптимальности) составляющих частей. Плохо обоснованные критические

утверждения о неоптимальном устройстве биологических систем объясняются

наличием компромиссов, присущих любой сложной системе.

Глава 4. Детерминизм в случайности

Это может звучать как оксюморон, но в случайности есть элементы детерминизма. Например, если монету многократно подбрасывают тысячи раз, количест

во выпавших орлов всегда будет стремиться к детерминированному значению

50 % от числа подбрасываний. Аналогичным образом многие программы, целью

которых является демонстрация ненаправленной эволюции, неизменно пишутся так, чтобы в большинстве случаев сходиться к конкретному детерминированному результату. Как и в случае со стальным шариком в автомате для игры

в пинбол, в каждом испытании можно выбрать разные пути, но стальной шарик

всегда заканчивает тем, что падает в маленькое отверстие под лопатками.

Принцип недостаточного обоснования Бернулли (Principle Of Insufficient Reason, PrOIR), несмотря на сложное название, просто говорит о том, что вероятность выиграть в лотерею с тысячей билетов – один шанс из тысячи, если вы

купили только один билет. Каждому возможному исходу в розыгрыше присва-

Краткое содержание глав 13

ивается равная вероятность. PrOIR Бернулли используется для моделирования

случайного слепого поиска.

Потолок Бейснера (Basener’s ceiling) накладывает строгое ограничение на

любой эволюционный процесс. Он гласит, что эволюционный компьютерный

поиск достигает точки, когда дальнейшее улучшение невозможно. Здравый

смысл подсказывает, что эволюционная программа, написанная для проектирования антенны, не будет продолжать развиваться до такой степени, что, например, самопроизвольно научится играть в шахматы. Теория, лежащая в основе этого ограничения эволюционных процессов, основывается на понятии

потолка Бейснера.

Глава 5. Сохранение информации в компьютерном поиске

Теперь у нас есть инструменты, необходимые для представления закона сохранения информации (Information Conservation Law, ICL), как показано в теореме об отсутствии бесплатных завтраков (No Free Lunch theorem, NFL). Теорема гласит, что при итеративном поиске произвольной цели один алгоритм

в среднем так же хорош, как и любой другой, если у разработчика нет никаких

априорных экспертных знаний в предметной области. Теорема, опубликованная в 1997 году Вольпертом (Wolpert) и Макреди (Macready), вызвала удивление

у сообщества машинного интеллекта, которое часто противопоставляло один

алгоритм поиска другому, чтобы определить, какой из них лучше. Получается,

что результаты такого конкурса ничего не говорят о тотальном преимуществе

одного алгоритма поиска над другим. Они лишь показывают, что определенный алгоритм поиска лучше подходит к исследуемой проблеме, и это преимущество не действует для других проблем.

Теорема об отсутствии бесплатных завтраков также послужила источником

вдохновения для книги Уильяма Дембски с аналогичным названием.

Если нет априорных экспертных знаний о предметной области, мы ожидаем, что слепой поиск будет работать так же хорошо, как и любой другой метод.

Проблема в том, что во многих случаях обращение к одной лишь случайности

быстро заводит в экспоненциальный тупик бесконечного числа вариантов.

Эффективная эволюция требует наличия информации.

Эволюционный поиск можно сделать лучше, чем в среднем, с помощью экспертизы предметной области. В этом случае для успешного поиска требуется

меньше итераций. Активная информация измеряет степень, в которой экспертиза предметной области помогает в поиске. Суть активной информации иллюстрируют легко понятные примеры, такие как головоломка Cracker Barrel

и игровое шоу «Давайте договоримся».

Утверждают, что теорема об отсутствии бесплатных завтраков была нарушена так называемым процессом коэволюции. Мы аргументированно показываем, что это не так.

Наконец, мы затрагиваем тему поиска поисков (метапоиска). Если все поисковые процедуры в среднем работают одинаково, разве у нас не может быть

14

Предисловие

компьютерного поиска для выявления поиска, который в определенной си

туации работает лучше среднего? Ответ оказывается решительным НЕТ! Показано, что метапоиск экспоненциально сложнее, чем сам поиск.

Глава 6. Анализ моделей биологической эволюции

Существует ряд компьютерных программ, предназначенных для демонстрации ненаправленной дарвиновской эволюции. Наиболее известной является

программа моделирования эволюции Avida, которой даже довелось участвовать в судебном процессе между сторонниками и противниками теории ненаправленной эволюции.

Поскольку Avida пытается решить относительно сложную задачу, разработчик программы, очевидно, внедрил в код программы знания предметной области. Мы определяем источники и измеряем внесенную активную информацию. Показано, что Avida содержит много хаотичной информации, снижающей

производительность. Когда беспорядок устранен, программа сходится к решению быстрее.

Другая эволюционная программа, исследованная на предмет выявления

и измерения активной информации, называется EV.

Когда в эволюционной программе выявлен внешний источник знаний, соответствующая активная информация может быть добыта иными способами

с помощью других поисковых программ. Как для Avida, так и для EV показаны

альтернативные программы поиска, которые дают те же результаты, что и эволюционный поиск, но с меньшей вычислительной нагрузкой.

На EvoInfo.org мы разработали интерактивные графические интерфейсы,

чтобы проиллюстрировать производительность как Avida, так и EV. Имеется

также графический интерфейс для экспериментального исследования алгоритма поиска Ричарда Докинза (Richard Dawkins), известного как алгоритм

«Ласка» (WEASEL algorithm). Устройство и использование этих графических

интерфейсов достаточно просты, так что читатель может выйти в интернет

и провести эксперимент самостоятельно.

Наконец, анализируется модель, предложенная Грегори Хайтиным (Gregory

Chaitin) в его книге «Доказывая Дарвина: математическая биология», изданной

в 2013 году. Модель Хайтина, построенная в красивом и сюрреалистическом

мире алгоритмической теории информации, оказывается переполненной активной информацией. К сожалению, как и другие компьютерные программы,

написанные для демонстрации ненаправленной дарвиновской эволюции, она

не является всеохватывающей.

Глава 7. Измерение смысла

и алгоритмическая заданная сложность

Заданная сложность (specified complexity) рассматривается как оценка степени значимости исходной или экспертной информации при создании объекта.

Краткое содержание глав 15

Алгоритмическая заданная сложность (Algorithmic Specified Complexity, ASC)

измеряет это свойство в битах.

ASC предполагает, что значимость объекта основана на контексте. Изображение моей семьи имеет большее значение для меня, чем для кого-то, кто никогда не встречал мою семью. Страница символов кандзи имеет большее значение для японского читателя, чем для человека, который не знает японский.

Примером могут служить выигрышные комбинации в игре в покер. Для колоды из 52 разных карт существует 2 869 682 возможных сочетания пяти карт.

Некоторые расклады, такие как флеш-рояль, более значимы, чем другие, – например, пара двоек. Мы показываем, что ASC флеш-рояля составляет 16 бит,

тогда как ASC расклада с одной парой равна нулю.

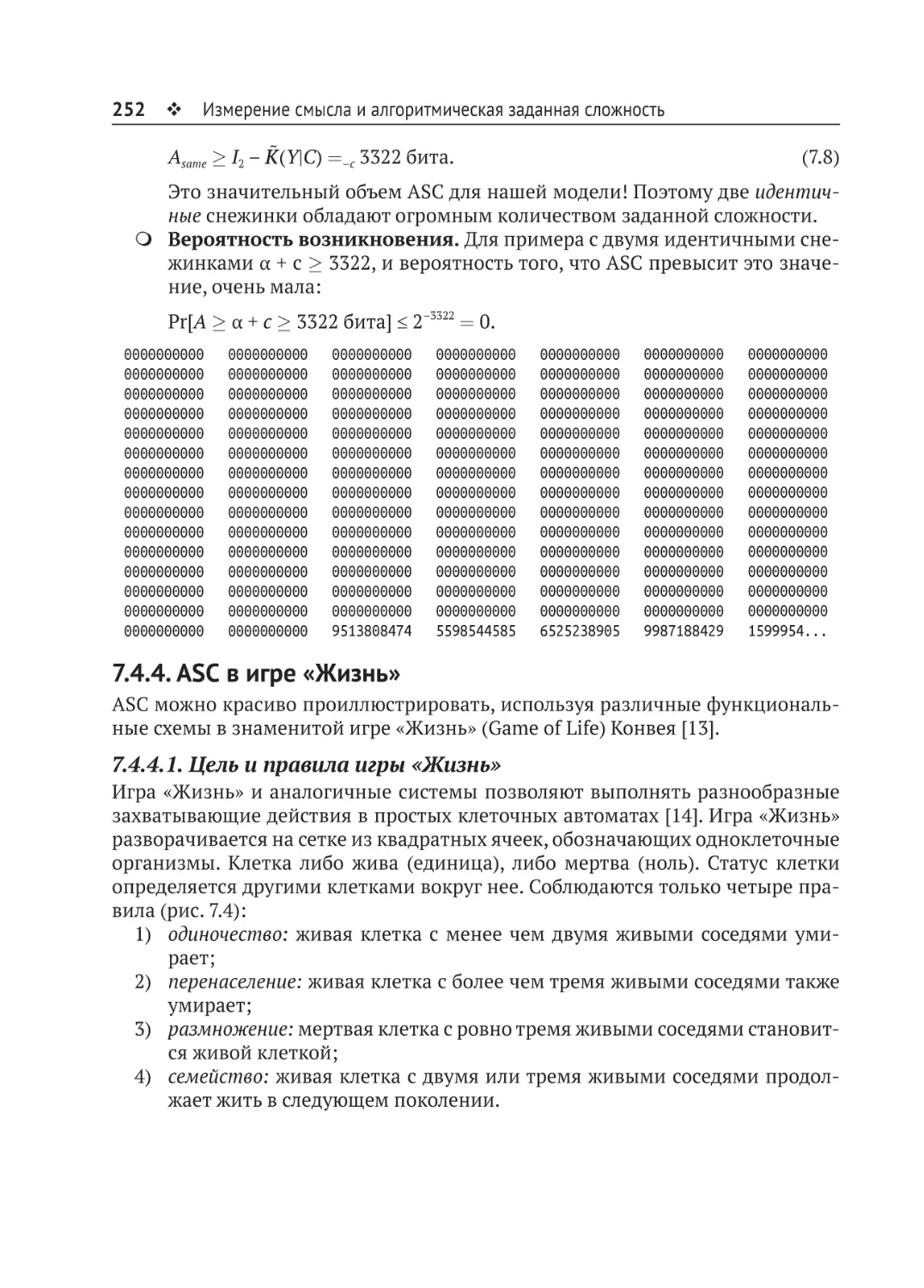

Другой иллюстративный пример касается снежинок. Хотя одиночная снежинка имеет высокую степень сложности, аналогичные события высокой

сложности случаются постоянно. Показано, что ASC двух разных снежинок

близка к нулю. Но у двух одинаковых снежинок очень большая ASC.

Наконец, рассчитывается ASC объектов в клеточных автоматах Конвея (Conway) Game of Life (игра «Жизнь»). Интерес к изобретенной в 1970 году игре продолжает расти. Сегодня существуют онлайновые группы пользователей, создающих сложные и замысловатые объекты с использованием четырех простых

правил Конвея. Как и ожидалось, крупным сложным объектам присваиваются

высокие значения ASC, тогда как простым объектам, которые с высокой вероятностью могут быть созданы случайным образом, присваиваются низкие

значения ASC.

Глава 8. Искусственный интеллект

и ограниченность компьютерных моделей

Безграничные возможности искусственного интеллекта (Artificial Intelligence,

AI) периодически подвергаются более или менее обоснованному сомнению.

Роджер Пенроуз (Roger Penrose) утверждает, что человеческий интеллект никогда не будет реализован с помощью машины Тьюринга (то есть компьютера).

Его аргументы, подкрепленные теоремой о неполноте (Incompleteness theorem) Курта Гёделя (Kurt Gödel), основаны на неспособности компьютеров быть

творцами сверх того, что им указано.

То же самое мы видим в моделях, которые симулируют дарвиновскую эволюцию. Снова и снова такие модели успешно работают в ограниченной области лишь потому, что программист внедрил в модель экспертную информацию. И конечно, эти модели работают на машине Тьюринга.

Дарвиновская эволюция не может создавать информацию из ничего, т. е.

не обладает способностью креативности. И ни один компьютер не может (по

крайней мере, пока ничто не указывает на такую возможность). Что касается креативности человеческого сознания, Пенроуз полагает, что ответ может

быть найден в квантовых явлениях, происходящих в наших нейронах.

16

Предисловие

Источники

1. William A. Dembski, The Design Inference: Eliminating Chance through Small Probabilities (Cambridge University Press, 1998).

William A. Dembski, No Free Lunch: Why Specified Complexity Cannot Be Purchased

without Intelligence (Rowman & Littlefield, Lanham, Md, 2002).

William A. Dembski, Being as Communion: A Metaphysics of Information (Ashgate

Publishing Ltd., 2014).

2. Bruce Gordon, William Dembski, editors, The Nature of Nature (Wilmington, Del,

2011).

R. J. Marks II, M. J. Behe, W. A. Dembski, B. L. Gordon, J. C. Sanford, editors, Biological Information – New Perspectives (Cornell University, World Scientific, Singapore,

2013).

3. William A. Dembski and Robert J. Marks II, «Conservation of Information in

Search: Measuring the Cost of Success». IEEE Transactions on Systems, Man and

Cybernetics A, Systems and Humans, vol. 39, #5, September 2009, pp. 1051–1061.

William A. Dembski, R. J. Marks II, «Bernoulli’s Principle of Insufficient Reason

and Conservation of Information in Computer Search». Proceedings of the 2009

IEEE International Conference on Systems, Man, and Cybernetics. San Antonio, TX,

USA – October 2009, pp. 2647–2652.

Winston Ewert, William A. Dembski and R. J. Marks II, «Evolutionary Synthesis of

Nand Logic: Dissecting a Digital Organism». Proceedings of the 2009 IEEE International Conference on Systems, Man, and Cybernetics. San Antonio, TX, USA – October 2009, pp. 3047–3053.

Winston Ewert, George Montañez, William A. Dembski, Robert J. Marks II, «Eff icient Per Query Information Extraction from a Hamming Oracle». Proceedings of

the 42nd Meeting of the Southeastern Symposium on System Theory. IEEE, University

of Texas at Tyler, March 7–9, 2010, pp. 290–229.

William A. Dembski, Robert J. Marks II, «The Search for a Search: Measuring the

In-formation Cost of Higher Level Search». J Adv Comput Intell Intelligent Inf,

14 (5), pp. 475–486 (2010).

George Montañez, Winston Ewert, William A. Dembski, Robert J. Marks II, «Vivisection of the EV Computer Organism: Identifying Sources of Active Information». Bio-Complexity, 2010 (3), pp. 1–6 (December 2010).

William A. Dembski, Robert J. Marks II, «Life’s Conservation Law: Why Darwinian

Evolution Cannot Create Biological Information». In Bruce Gordon and William

Dembski, eds., The Nature of Nature (ISI Books, Wilmington, Del., 2011), pp. 360–

399.

Winston Ewert, William A. Dembski, Robert J. Marks II, «Climbing the Steiner

Tree – Sources of Active Information in a Genetic Algorithm for Solving the Euclidean Steiner Tree Problem». Bio-Complexity, 2012 (1), pp. 1–14 (April, 2012).

Источники 17

Winston Ewert, William A. Dembski, Ann K. Gauger, Robert J. Marks II, «Time and

Information in Evolution». Bio-Complexity, 2012 (4) 7 pages. doi:10.5048/BIOC.2012.4.

Winston Ewert, William A. Dembski Robert J. Marks II, «On the Improbability of

Algorithmically Specified Complexity». Proceedings of the 2013 IEEE 45th Southeastern Symposium on Systems Theory (SSST), Baylor University, March 11, 2013,

pp. 68–70.

Jon Roach, Winston Ewert, Robert J. Marks II, Benjamin B. Thompson, «Unexpected Emergent Behaviors from Elementary Swarms». Proceedings of the 2013

IEEE 45th Southeastern Symposium on Systems Theory (SSST), Baylor University,

March 11, 2013, pp. 41–50.

Winston Ewert, William A. Dembski and Robert J. Marks II, «Conservation of Infomation in Relative Search Performance». Proceedings of the 2013 IEEE 45th SouthEastern Symposium on Systems Theory (SSST), Baylor University, March 11, 2013,

pp. 41–50.

Albert R. Yu, Benjamin B. Thompson, and Robert J. Marks II, «Competitive evolution of tactical multiswarm dynamics». IEEE Transactions on Systems, Man and

Cybernetics: Systems, 43 (3), pp. 563–569 (May 2013).

Robert J. Marks II, «Information Theory & Biology: Introductory Comments».

Biological Information – New Perspectives, edited by R. J. Marks II, M. J. Behe,

W. A. Dembski, B.L. Gordon, J.C. Sanford (World Scientific, Singapore, 2013)

pp. 1–10.

William A. Dembski, Winston Ewert, Robert J. Marks II, «A General Theory of Infomation Cost Incurred by Successful Search». Biological Information – New Perspectives, edited by R. J. Marks II, M. J. Behe, W. A. Dembski, B. L. Gordon, J. C. Sanford

(World Scientific, Singapore, 2013) pp. 26–63.

W. Ewert, William A. Dembski, Robert J. Marks II, «Tierra: The Character of

Adaptation». Biological Information – New Perspectives, edited by R. J. Marks II,

M. J. Behe, W. A. Dembski, B. L. Gordon, J. C. Sanford (World Scientific, Singapore,

2013), pp. 105–138.

G. Montañez, Robert J. Marks II, Jorge Fernandez, John C. Sanford, «Multiple Overlapping Genetic Codes Profoundly Reduce the Probability of Beneficial Mutation». Biological Information – New Perspectives, edited by R. J. Marks II, M. J. Behe,

W. A. Dembski, B. L. Gordon, J. C. Sanford (World Scientific, Singapore, 2013),

pp. 139–167.

W. Ewert, William A. Dembski, Robert J. Marks II, «Algorithmic specified complexity». Engineering and the Ultimate: An Interdisciplinary Investigation of Order and

Design in Nature and Craft, edited by J. Bartlett, D. Halsmer, M. Hall (Blyth Institute Press, 2014), pp. 131–149.

W. Ewert, Robert J. Marks II, Benjamin B. Thompson, Al. Yu, «Evolutionary inversion of swarm emergence using disjunctive combs control». IEEE Transactions on

Systems, Man and Cybernetics: Systems, 43 (5), pp. 1063–1076 (September 2013).

18

Предисловие

W. Ewert, William A. Dembski, Robert J. Marks II, «Algorithmic Specified Complexity in the Game of Life». IEEE Transactions on Systems, Man and Cybernetics:

Systems, 45 (4), pp. 584–594 (April 2015).

W. Ewert, William A. Dembski, Robert J. Marks II, «Measuring meaningful information in images: algorithmic specified complexity». IET Computer Vision (2015).

DOI: 10.1049/iet-cvi.2014.0141.

Об авторах

Роберт Дж. Маркс (Robert J. Marks) – заслуженный профессор технических наук инженерного факультета Университета Бэйлор, США. Маркс является членом IEEE и Оптического общества Америки. Его консалтинговая деятельность

включает корпорацию Microsoft, DARPA и Boeing Computer

Services. Он внес серьезный научный вклад в области обработки сигналов, включая распределение частоты по времени Чжао–Атласа–Маркса (Zhao–Atlas–Marks, ZAM) и тео

рему Ченга–Маркса в теории дискретизации Шеннона. Он

входит в список 50 самых влиятельных ученых в мире на

сегодняшний день по версии TheBestSchools.org (2014).

Исследования Маркса финансировались такими организациями, как Национальный научный фонд США, General Electric, Southern California Edison,

Boeing Defense, Научно-исследовательский центр Военно-воздушных сил

США, Военно-морской исследовательский институт США, Военно-морская исследовательская лаборатория США, Фонд Уитакера, Национальный институт

здравоохранения, Лаборатория реактивного движения, Исследовательский

центр армии США и NASA. Его книги включают «Справочник по анализу Фурье

и его приложениям» (издательство Оксфордского университета), «Введение

в теорию выборки и интерполяции Шеннона» (Springer Verlag) и «Нейронное

связывание: контролируемое обучение в искусственных нейронных сетях

прямой связи» (MIT Press) в соавторстве с Рассом Ридом. Маркс редактировал

пять других работ в таких областях, как энергетика, нейронные сети и нечеткая

логика. Он сыграл важную роль в определении дисциплины вычислительного

интеллекта и является редактором первой книги, использующей этот термин

в названии: «Вычислительный интеллект: имитация жизни» (IEEE Press, 1994).

Его авторские и соавторские главы данной книги вобрали в себя девять работ,

ранее изданных в сборниках академических трудов. Другие главы книги включают материалы из «Справочника по теории мозга и нейронных сетей» Майкла Арбиба (MIT Press, 1996). Его число Эрдёша–Бэйкона (Erdős–Bacon number)1

равно пяти.

1

https://ru.wikipedia.org/wiki/Число_Эрдёша_–_Бэйкона.

20

Об авторах

Уильям А. Дембски (William A. Dembski) – старший научный сотрудник лаборатории эволюционной информатики

в Макгрегоре, штат Техас, а также предприниматель, разрабатывающий образовательные веб-сайты и программное обеспечение. Он обладатель степеней бакалавра по

психологии, степени магистра по статистике, кандидата

экономических наук и доктора физико-математических

наук (степень присвоена в 1988 году Чикагским университетом, Чикаго, Иллинойс, США). Уильям Дембски работал

ассоциированным профессором кафедры науковедения

Университета Бэйлор (Уэйко, Техас, США), преподавал в Северо-Западном университете (Эванстон, Иллинойс, США), в университете Нотр-Дам (Нотр-Дам,

Индиана, США) и в университете Далласа (Ирвинг, Техас, США). Он защитил

докторскую работу по математике в Массачусетском технологическом институте (Кембридж, США), по физике в Чикагском университете (Чикаго, США)

и по информатике в Принстонском университете (Принстон, Нью-Джерси,

США). Он организовал стипендии для выпускников и докторантов Национального научного фонда, опубликовал статьи в журналах по математике, инженерии и философии и является автором и редактором более двадцати книг. Уиль

ям Дембски – математик и философ, взявший на себя роль публичного

интеллектуала. В дополнение к чтению лекций по всему миру в колледжах

и университетах он много выступал на радио и телевидении. Его работы цитировались в многочисленных газетных и журнальных статьях, в том числе в трех

статьях на первой полосе в «Нью-Йорк таймс», а также в обложке журнала

«Тайм» от 15 августа 2005 года. Он появлялся на различных телешоу каналов

BBC, NPR (Дайан Рем и др.), PBS («Взгляд изнутри» с Джеком Фордом и «Не

обыкновенное знание» с Питером Робинсоном), CSPAN2, CNN, Fox News, ABC

Nightline и «Ежедневные новости» с Джоном Стюартом.

Уинстон Эверт (Winston Ewert) в настоящее время работает инженером-программистом в Ванкувере, Канада. Он

старший научный сотрудник лаборатории эволюционной

информатики. Эверт получил докторскую степень в университете Бэйлора (Уэйко, Техас, США). Он написал ряд

статей на тему поиска, информации и сложности, включая

исследования компьютерных моделей, предназначенных

для описания дарвиновской эволюции, и разработку теоретико-информационных моделей для измерения вычислительной сложности. Доктор Эверт является постоянным

автором EvolutionNews.org.

Глава

1

Введение

Честь математики требует от нас разработать

математическую теорию эволюции и либо доказать, что Дарвин был прав, либо опроверг

нуть его!

Грегори Хайтин [1]

Авторитетная и заслуживающая уважения наука должна опираться на математику и модели. Даже некоторые нестрогие науки, такие как социология или

финансы, предлагают убедительные математические и компьютерные модели, получающие Нобелевские премии. Целью эволюционной информатики является изучение математики и моделей, лежащих в основе эволюции.

Существует очевидная разница между моделями и реальностью. Инженеры любят шутить: «В теории наука и реальность совпадают. На практике это

не так». Модели в физике показали невероятное экспериментальное согласие

с теорией. Но как насчет дарвиновской эволюции? Было предложено множест

во моделей для эволюции по Дарвину. Некоторые из них рассматриваются

в этой монографии. Каждая из них, однако, заранее продумана до мелочей,

и степень их предопределенности может быть измерена в битах с использованием понятия активной информации. Если допустить, что эти модели исчерпывающе отражают дарвиновский процесс, то приходится сделать вывод, что

эволюция невозможна без полученной извне начальной информации. Проб

лема большинства моделей эволюции заключается в том, что без некоторой

доли заложенной в них начальной информации упомянутые модели просто

не работают. Комбинаторных ресурсов нашей вселенной и даже основанной

на теории струн современной модели мультивселенной недостаточно, чтобы

реализовать эволюцию, основанную исключительно на длинной цепочке событий с ничтожной вероятностью. Здесь явно не обойтись без неких всеобщих

алгоритмических законов. Мы намерены показать это в своей книге.

Наша работа была первоначально мотивирована попытками других авторов

описать эволюцию Дарвина с помощью компьютерного моделирования или

математических моделей [2]. Авторы этих работ утверждают, что их модели

достоверно отражают ненаправленную биологическую эволюцию. Мы неоднократно показываем, что все предложенные модели требуют значительных

22

Введение

предварительных знаний о решаемой проблеме. Но если цель модели указана

заранее, это уже не дарвиновская эволюция, а разумный замысел, где разработчик программы выступает в роли созидающего божества. По иронии судьбы, модели эволюции, призванные продемонстрировать эволюцию Дарвина,

нуждаются в разумном разработчике. Вклад программиста в успех модели, называемый активной информацией, можно измерить в битах.

Понятие активной (или значимой) информации имеет фундаментальное

значение. Бюсты президентов США на склоне горы Рашмор демонстрируют

наличие активной информации по сравнению, скажем, с горой Фудзи. Проект

поиска внеземного разума (SETI) предполагает, что на фоне случайного космического шума можно обнаружить интеллектуальные сигналы, содержащие

активную информацию. Модель для измерения значимой информации, получаемой из наблюдений, является темой главы 7.

1.1. Королева ученых и инженеров

Инженеры мало хвастаются своими успехами. Однако в конечном итоге не

ученые, а инженеры отправили человека на луну. Не ученые отвечают за работу интернета. Это делают инженеры. Последние прорывы в медицине – это,

скорее всего, работа инженера, а не ученого или врача. Вещи созданы инженерами.

Назначение инженера состоит в том, чтобы понимать природу и математику, применять это понимание к реальности и заставлять вещи работать.

Между инженерами и учеными есть фундаментальные философские различия. Ученые, как правило, больше заинтересованы в общем понимании явлений. Они формируют модели реальности – часто красивые и мощные – и тщательно их изучают. После того как модель более или менее выдержала проверку

практикой, ее возводят на трон, словно королеву, и поклоняются ей. Иногда

требуется революция, чтобы свергнуть научную догму. Инженеры, напротив,

заставляют королеву сойти с трона и пойти мыть пол. Если она работает, мы

используем ее навыки. Но если она не работает, мы ее прогоняем.

Эта монография описывает историю королевы. Мы анализируем компьютерные модели эволюции, предлагаемые учеными, и заключаем, что они работают только потому, что программисты создали их для работы. В них нет

создания информации или спонтанного увеличения значимой сложности. Информация не возникает из ниоткуда – это противоречит закону сохранения

информации. Мы можем изучить предложенные компьютерные модели, определить источник активной информации1 и показать, что, несмотря на успешное моделирование некоторых аспектов эволюции, эти модели являются плохим способом использования доступных вычислительных ресурсов. Поскольку

1

В нашем случае – информации, заложенной программистом при создании программы и напрямую определяющей работоспособность модели.

Наука и модели 23

предлагаемые модели некорректно отображают характеристики ненаправленного дарвиновского поиска, им пора слезать с трона.

1.2. Наука и модели

Наука нуждается в поясняющих моделях. Дарвиновская эволюция, использую

щая повторяющиеся процессы случайной мутации организмов, на первый

взгляд выглядит наукой, которая идеально подходит для вероятностного моделирования.

Неоднократно наблюдаемые физические законы и явления, такие как закон движения Ньютона или законы термодинамики, всегда будут работать

одинаково, сколько бы мы ни повторяли эксперименты. Говорят, что такие законы формируются путем применения индуктивного вывода. Соответственно,

мы можем достаточно легко построить однозначные компьютерные модели,

имитирующие эти законы. Однако неповторяемые явления не могут быть смоделированы таким образом. Характерным примером является теория Большого взрыва. В подобных случаях для вывода законов используется абдуктивный

(умозрительный) вывод или вывод с наилучшим объяснением. Абдуктивный вывод, безусловно, не помешал нам сформировать богатое теоретическое объяснение Большого взрыва или теоретический базис геологии.

К сожалению, мы не можем повторить в лаборатории весь ход дарвиновской эволюции за прошедшие миллиарды лет существования жизни на Земле.

Однако современная наука довольно глубоко исследовала некоторые наблюдаемые и воспроизводимые явления, которые могли бы помочь. Мы умеем

разводить породистых собак и лошадей, штаммы бактерий вырабатывают

устойчивость к антибиотикам, а клювы зябликов различаются в зависимости

от источников пищи на Галапагосских островах. Разве мы не можем экстраполировать жизнеспособную математическую модель эволюции исходя из этих

явлений? Некоторые оптимистично настроенные ученые говорят уверенное

«да». Однако с точки зрения математики экстраполяция стохастических последовательностей невероятно сложна. Малейшие различия в наблюдениях могут

привести к абсолютно разным результатам экстраполяции1 [3]. Глава 6 содержит обсуждение опубликованных моделей, сторонники которых считают, что

у них есть успешная модель дарвиновской эволюции. Увы, это не так. В лучшем

случае они смоделировали целенаправленную селекцию породистых лошадей

из имеющегося поголовья.

1

⍟ Примеры характеристик экстраполяции и прогнозирования включают в себя слабообусловленные (ill-conditioned) и некорректные (ill-posed) процессы. Слабообусловленный процесс – это процесс, при котором небольшие изменения в наблюдаемых

данных могут привести к огромным изменениям в экстраполяции. Некорректный

процесс является крайним проявлением слабообусловленного процесса. Независимо от того, насколько мало нарушена известная часть процесса, изменение ошибки

экстраполяции становится неизвестным в том смысле, что оно не имеет предсказуемых границ.

24

Введение

1.2.1. Компьютерные модели

Появление компьютеров в середине ХХ века породило радужные ожидания

среди ученых-эволюционистов. Всем хотелось верить, что процесс эволюции наконец-то будет смоделирован и продемонстрирован компьютерной

программой. Надежды на эволюционные вычислительные модели были основаны на предположении, что, в отличие от неторопливого «биологического программного обеспечения», быстродействующие компьютеры позволят

убедительно смоделировать дарвиновскую эволюцию в обозримом будущем.

В 1962 году Нильс Барричелли (Nils Barricelli) написал [4]:

«Дарвиновская идея о том, что эволюция происходит путем случайных наследственных изменений и отбора, с самого начала страдала от того, что не было

найдено надлежащего теста для определения возможности такой эволюции

и наблюдения за ее развитием в контролируемых условиях».

В середине 60-х годов Дж. Л. Кросби (J. L. Crosby) [5] обратился к компьютеру

будущего как к лекарству от этого состояния:

«В целом обычно невозможно или почти невозможно проверить гипотезы об

эволюции конкретного вида путем преднамеренного проведения контролируемых экспериментов с живыми организмами этого вида. Мы можем попытаться частично обойти эту трудность, построив [компьютерные] модели, представляющие эволюционную систему, которую мы хотим изучать, и использовать их

для проверки, по крайней мере, теоретической обоснованности наших идей».

1.2.2. Невероятное и невозможное

Вопреки ожиданиям, компьютерные исследования выявили многочисленные

проблемы – и даже не столько эволюции как таковой, сколько вероятностного

подхода к моделированию эволюции. Принцип сохранения информации показывает, что эволюционные модели неспособны генерировать информацию.

Скорее, они ограничены извлечением информации из источника знаний. Успех

любой модели эволюционного процесса связан не с магией в самом процессе,

а с творческими знаниями, доступными для этого процесса. Компьютерное

моделирование эволюции продемонстрировало, что источники информации

создаются программистами, использующими свои априорные знания проб

лемного пространства, – процесс, не имеющий аналогов в объективном мире.

В чем же проблема моделей эволюции? Эти модели являются стохастическими, поэтому можно утверждать: «Конечно, это маловероятно. Но это возможно!» Да, это верно в том смысле, что все вероятные вещи возможны, но

проблема в том, что не все возможные вещи достаточно вероятны. Или, иначе говоря, все невозможное является невероятным, но невероятные события

не должны быть невозможными. Но в какой-то момент невероятное и невозможное сливается воедино, и в рамках ресурсов нашей наблюдаемой вселенной (или даже предполагаемой мультивселенной) событие может быть настолько невероятным, что его можно определенно обозначить как невозможное.

Источники 25

Это положение обычно называют законом Бореля (Borel’s law) [6]. Когда я стою

на полу, может ли часть моей ноги испытать квантовое туннелирование через

пол? Да. Но событие настолько невероятно, что я могу безбоязненно стоять

и сидеть миллиарды лет, и пальцы моих ног никогда не испытают квантовое

туннелирование. Поэтому мы утверждаем, что это технически возможное событие действительно невозможно на практике. Вот еще один пример. Предположим, я случайно выбрал миллиард атомов в известной вселенной, и, не

советуясь со мной, вы тоже выбрали миллиард атомов. Строго говоря, вполне

возможно, что мы выберем одинаковый миллиард атомов. Но вероятность

полного совпадения миллиарда атомов настолько мала, что мы могли бы выбирать атомы снова и снова на протяжении триллионов лет без малейшего

шанса на совпадение.

Можно ли построить идеально стохастическую (не содержащую активной

информации), но при этом успешную модель ненаправленной дарвиновской

эволюции? Теоретически существует незначительная вероятность того, что эта

модель воспроизведет эволюцию, но, как и в примерах квантового туннелирования и выбора миллиарда атомов, на практике это невозможно. Эволюционная информатика показывает, что наблюдаемая вселенная (или даже мульти

вселенная) недостаточно велика и недостаточно стара, чтобы позволить этому

случиться.

Источники

1. G. J. Chaitin, Proving Darwin: Making Biology Mathematical (Pantheon, 2012).

2. H. S. Wilf, W. J. Ewens, «There’s plenty of time for evolution». P Natl Acad Sci, 107,

pp. 22454–22456 (2010).

R. E. Lenski, C. Ofria, R. T. Pennock, C. Adami, «The evolutionary origin of complex

features». Nature, 423, pp. 139–144 (2003).

T. D. Schneider, «Evolution of biological information». Nucleic Acids Res, 28,

pp. 2794–2799 (2000).

R. Dawkins, The Blind Watchmaker: Why the Evidence of Evolution Reveals a Universe Without Design (Norton, New York, 1996).

D. Thomas, «War of the Weasels: An evolutionary algorithm beats intelligent design». Skeptical Inquirer, 43, pp. 42–46 (2010).

G. J. Chaitin, Proving Darwin: Making Biology Mathematical (Pantheon, 2012).

3. R. J. Marks II, Handbook of Fourier Analysis and its Applications (Oxford University

Press, 2008).

R. J. Marks II, «Gerchberg’s extrapolation algorithm in two dimensions». Appl Opt,

20, pp. 1815–1820 (1981).

D. K. Smith, R. J. Marks II, «Closed form bandlimited image extrapolation». Appl

Opt, 20, pp. 2476–2483 (1981).

26

Введение

R. J. Marks II, «Posedness of a bandlimited image extension problem in tomography». Opt Lett, 7, pp. 376–377 (1982).

D. Kaplan, R. J. Marks II, «Noise sensitivity of interpolation and extrapolation

matrices». Appl Opt, 21, pp. 4489–4492 (1982).

R. J. Marks II, «Restoration of continuously sampled bandlimited signals from

aliased data». IEEE Transactions on Acoustics, Speech and Signal Processing,

ASSP-30, pp. 937–942 (1982).

R. J. Marks II, D. K. Smith, «Gerchberg-type linear deconvolution and extrapolation algorithms». Transformations in Optical Signal Processing, W. T. Rhodes,

J. R. Fienup, B. E. A. Saleh (eds.), SPIE 373, pp. 161–178 (1984).

K. F. Cheung, R. J. Marks II, L. E. Atlas, «Convergence of Howard’s minimum negativity constraint extrapolation algorithm». J Opt Soc Am A, 5, pp. 2008–2009

(1988).

4. N. A. Barricelli, «Numerical testing of evolution theories, Part I: theoretical introduction and basic tests». Acta Biotheor, 16 (1–2), pp. 69–98 (1962). Переиздано:

David B. Fogel (ред.), Evolutionary Computation: The Fossil Record (IEEE Press,

Piscataway N. J., 1998).

5. J. L. Crosby, «Computers in the study of evolution». Sci Prog Oxf, 55, pp. 279– 292

(1967).

6. David J. Hand, The Improbability Principle: Why Coincidences, Miracles, and Rare

Events Happen Every Day (Macmillan, 2014).

Глава

2

Информация:

что это такое?

Каждая новая область исследований в итоге

обретает форму математики, потому что у нас

нет другого инструмента науки.

Чарльз Дарвин [1]

2.1. Определение информации

Термин «информация» часто встречается в научных публикациях, но его точное определение [2] варьируется в широких пределах. При попытке дать точное определение информации возникает ряд вопросов.

Диск Blu-ray способен хранить около 50 Гб цифровых данных. Отличается ли объем информации на диске, если диск содержит фильм «Храброе

сердце» или набор случайных шумов?

Если книга необратимо уничтожена, то будет ли уничтожена информация? Имеет ли значение, сохранилась другая копия книги или нет?

Когда делается цифровой фотоснимок, цифровая информация создается

или просто захватывается?

Если вам показывают документ, написанный на китайском диалекте

мандарин, содержит ли он информацию, даже если вы не понимаете

мандарин? А что, если документ написан на иностранном языке, не известном ни одному ныне живущему человеку? Если нет, то будет ли документ содержать информацию, если мы внезапно обнаружим камень

Розетты, допускающий перевод документа?

Ответы на эти вопросы различаются в зависимости от определения информации. Информация может быть наложена на энергию. В качестве примера

можно назвать акустические звуковые волны, применяемые людьми и другими живыми существами для общения, или электромагнитные волны, излучаемые радиостанциями. Как и в случае с книгами и дисками Blu-ray, информация

также может быть механически отпечатана на носителе. Но энергия и материя

Powered by TCPDF (www.tcpdf.org)

28

Информация: что это такое?

служат только средством переноса информации. Норберт Винер (Norbert Weiner) [3], отец кибернетики, весьма афористично отметил [4]:

«Информация – это не материя и не энергия. Информация – это информация».

Информация непрерывно циркулирует в творческих процессах, а инженеры

и изобретатели все время копируют природные проекты. Например, идея застежки-липучки возникла в результате тщательного изучения семян сорняка,

застрявших в одежде швейцарского инженера после поездки на охоту. Функция

человеческого века послужила источником вдохновения для изобретения очис

тителей ветрового стекла автомобиля [5]. Общество компьютерного интеллекта

[6] при IEEE1 имеет девиз: «Решения проблем, вдохновленные природой». Природные явления могут быть богатым источником полезной информации.

Материя и энергия смоделированы и хорошо изучены физиками. Однако не

существует универсальной модели информации. Клод Шеннон (Claude Shannon) признал, что его знаменитая теория информации является отнюдь не последним словом в математическом моделировании информации [7]:

«Мне кажется, что мы все определяем “информацию” по своему выбору; и, в зависимости от того, в какой области мы работаем, мы будем выбирать различные

определения. Моя собственная модель теории информации ... была создана

специально для работы с проблемой коммуникации».

Определение информации Шеннона страдает от неспособности измерить

смысл. Диск Blu-ray со случайным шумом может иметь такое же количество

битов, как диск, содержащий фильм «Храброе сердце».

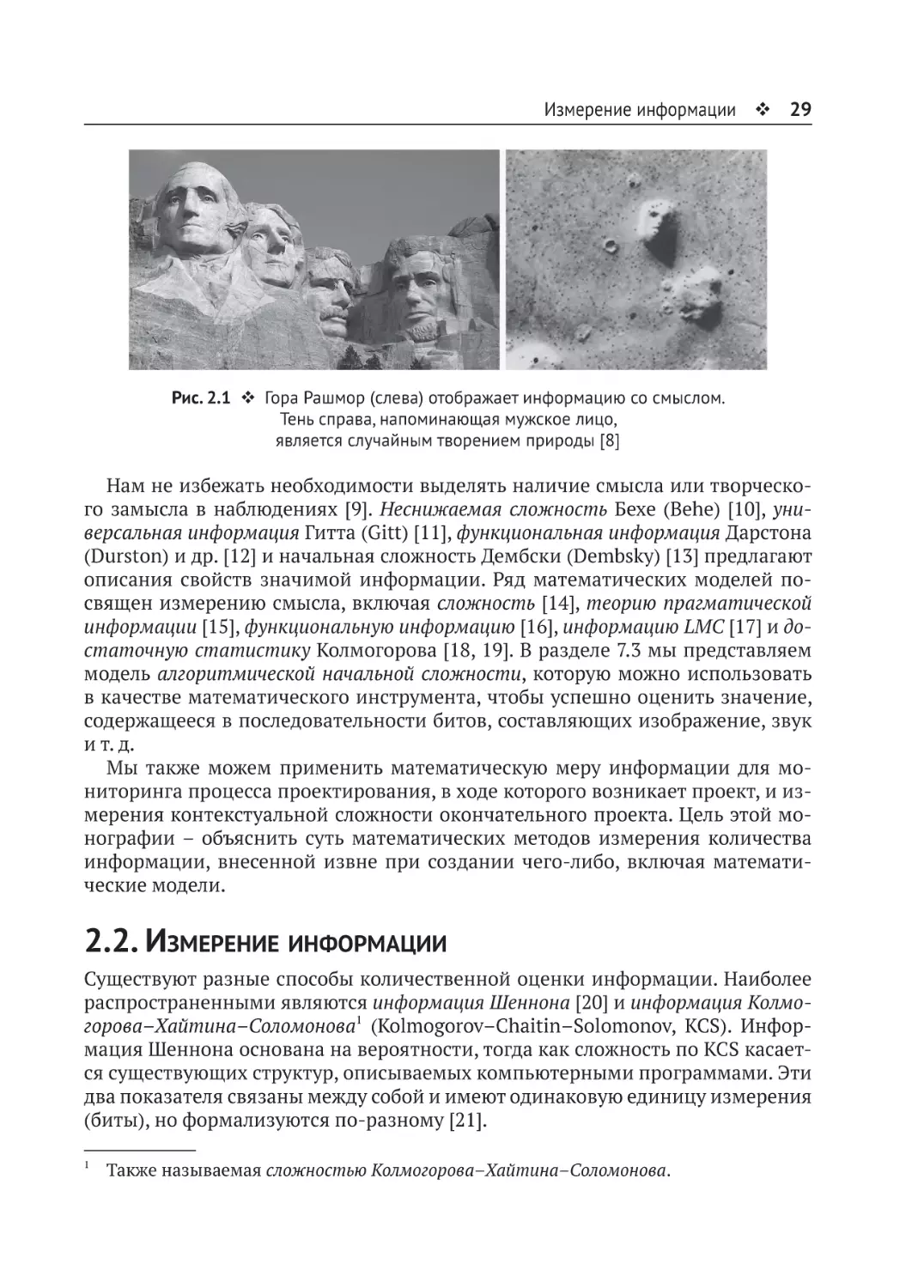

Популярный пример информации, содержащей смысл, показан на рис. 2.1.

Слева изображение явно рукотворной горы Рашмор (Rushmore). Справа тени

напоминают лицо человека. Это фотография поверхности Марса, сделанная во

время миссии NASA «Викинг-1» в 1976 году. Если учитывать тысячи теней на

поверхности Марса, меняющихся в зависимости от угла освещения солнцем,

неудивительно, что некоторые узоры могут напоминать лицо человека. Изобра

жение справа является случайным. Особое свойство информации, которое позволяет нам отличать осмысленные скульптуры на горе Рашмор от «лица» на

поверхности Марса, – это заданная сложность (specified complexity). Изображения на горе Рашмор – это не просто лица людей. Это конкретные люди: Вашингтон, Джефферсон, Рузвельт и Линкольн. Большинству людей лицо на Марсе не

напоминает никого конкретно. Изображения на Рашморе сложны и содержат

преднамеренные изображения глаз, волос, ноздрей, рта и ушей. Как и в случае

дисков Blu-ray с «Храбрым сердцем» и шумом, чистая информация Шеннона не

поможет нам сравнить два изображения на рис. 2.1 и сообщить о наличии или

отсутствии начальной сложности, исходя из статистики пикселей.

1

IEEE, Институт инженеров по электротехнике и электронике, является крупнейшим

в мире профессиональным обществом. В 2016 году в 160 странах насчитывалось

421 000 членов.

Измерение информации 29

Рис. 2.1 Гора Рашмор (слева) отображает информацию со смыслом.

Тень справа, напоминающая мужское лицо,

является случайным творением природы [8]

Нам не избежать необходимости выделять наличие смысла или творческого замысла в наблюдениях [9]. Неснижаемая сложность Бехе (Behe) [10], универсальная информация Гитта (Gitt) [11], функциональная информация Дарстона

(Durston) и др. [12] и начальная сложность Дембски (Dembsky) [13] предлагают

описания свойств значимой информации. Ряд математических моделей посвящен измерению смысла, включая сложность [14], теорию прагматической

информации [15], функциональную информацию [16], информацию LMC [17] и достаточную статистику Колмогорова [18, 19]. В разделе 7.3 мы представляем

модель алгоритмической начальной сложности, которую можно использовать

в качестве математического инструмента, чтобы успешно оценить значение,

содержащееся в последовательности битов, составляющих изображение, звук

и т. д.

Мы также можем применить математическую меру информации для мониторинга процесса проектирования, в ходе которого возникает проект, и измерения контекстуальной сложности окончательного проекта. Цель этой монографии – объяснить суть математических методов измерения количества

информации, внесенной извне при создании чего-либо, включая математические модели.

2.2. Измерение информации

Существуют разные способы количественной оценки информации. Наиболее

распространенными являются информация Шеннона [20] и информация Колмогорова–Хайтина–Соломонова1 (Kolmogorov–Chaitin–Solomonov, KCS). Информация Шеннона основана на вероятности, тогда как сложность по KCS касается существующих структур, описываемых компьютерными программами. Эти

два показателя связаны между собой и имеют одинаковую единицу измерения

(биты), но формализуются по-разному [21].

1

Также называемая сложностью Колмогорова–Хайтина–Соломонова.

30

Информация: что это такое?

2.2.1. Cложность по KCS

Те, кто знаком с компьютерами, знают о программах для сжатия информации,

создающих ZIP-файлы и изображения в формате JPG. Большие файлы уменьшаются за счет устранения избыточности. Сжатые файлы передаются быстрее

и восстанавливаются получателем. Технология сжатия файлов похожа на производство обезвоженной пищи. Вода удаляется на заводе. Обезвоженная пища

мало весит, и доставка до места назначения обходится дешевле. Получатель

повторно увлажняет и – в идеале – восстанавливает у себя исходную еду. Аналогично сжатые файлы могут передаваться с использованием ограниченной

полосы пропускания и восстанавливаться в приемнике.

Регидратированная пища редко бывает столь же вкусна, как и оригинал. Процесс дегидратации часто приводит к потере или нежелательным изменениям

вкуса, аромата или текстуры исходного продукта. Некоторые методы сжатия

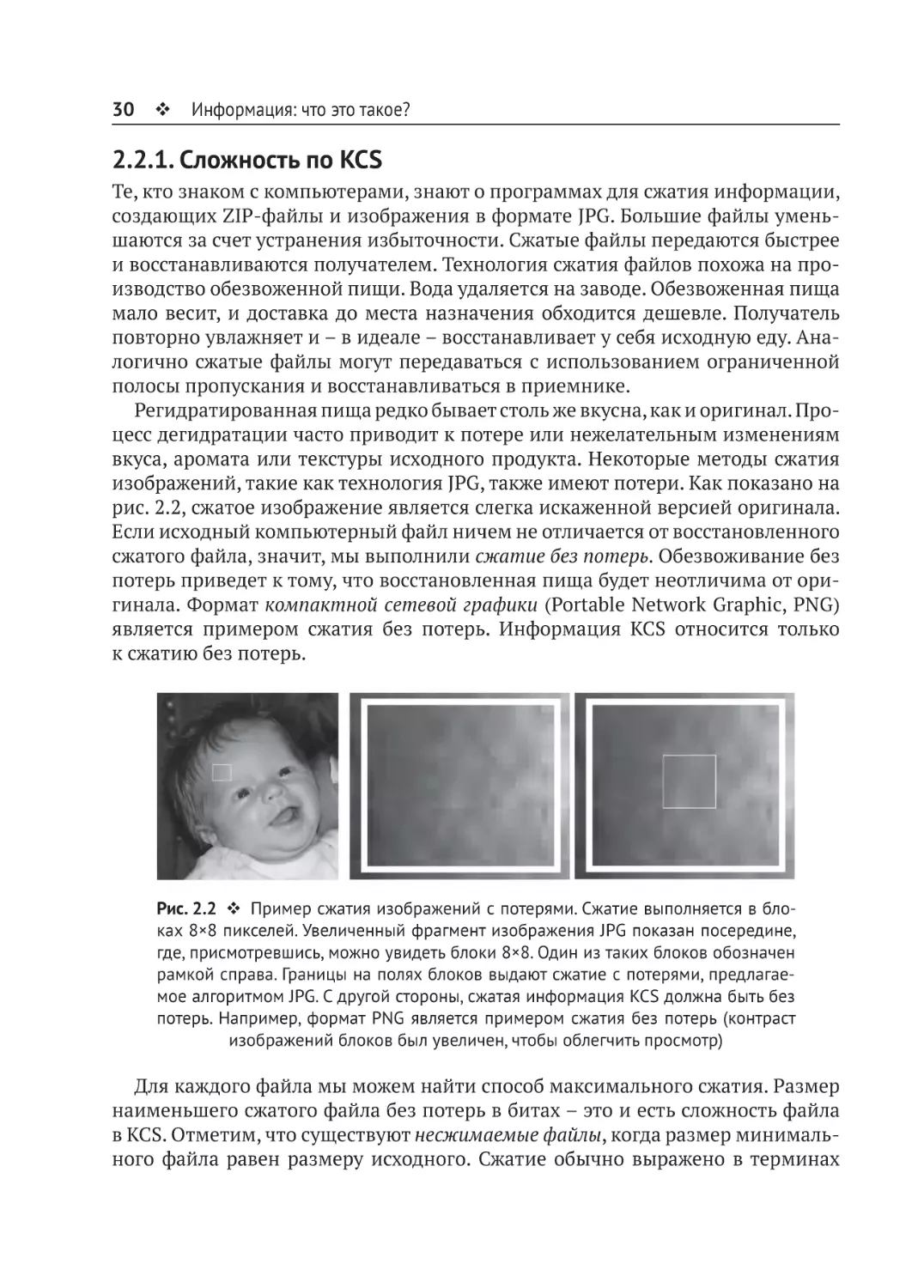

изображений, такие как технология JPG, также имеют потери. Как показано на

рис. 2.2, сжатое изображение является слегка искаженной версией оригинала.

Если исходный компьютерный файл ничем не отличается от восстановленного

сжатого файла, значит, мы выполнили сжатие без потерь. Обезвоживание без

потерь приведет к тому, что восстановленная пища будет неотличима от оригинала. Формат компактной сетевой графики (Portable Network Graphic, PNG)

является примером сжатия без потерь. Информация KCS относится только

к сжатию без потерь.

Рис. 2.2 Пример сжатия изображений с потерями. Сжатие выполняется в блоках 8×8 пикселей. Увеличенный фрагмент изображения JPG показан посередине,

где, присмотревшись, можно увидеть блоки 8×8. Один из таких блоков обозначен

рамкой справа. Границы на полях блоков выдают сжатие с потерями, предлагаемое алгоритмом JPG. С другой стороны, сжатая информация KCS должна быть без

потерь. Например, формат PNG является примером сжатия без потерь (контраст

изображений блоков был увеличен, чтобы облегчить просмотр)

Для каждого файла мы можем найти способ максимального сжатия. Размер

наименьшего сжатого файла без потерь в битах – это и есть сложность файла

в KCS. Отметим, что существуют несжимаемые файлы, когда размер минимального файла равен размеру исходного. Сжатие обычно выражено в терминах

Измерение информации 31

компьютерной программы, способной воспроизвести объект. Какая самая короткая компьютерная программа способна точно описать файл?

Какой размер может иметь информация KCS? Большой файл размером B бит,

очевидно, не может быть сжат без потерь в один бит. В то же время файл B бит

может быть представлен несжатым файлом длиной B бит. В таком случае мы

просто задаем нужную последовательность битов в компьютерной программе

и говорим PRINT и HALT. Если Y обозначает самую короткую программу для битовой последовательности X, то мы знаем, что длина Y лежит где-то между одним

битом и значением, несколько превышающим B бит1. Наименьший сжатый без

потерь файл имеет битовую длину K(X) – это информационное (или сложное)

содержание KCS файла большего размера. Хайтин называет эти программы

элегантными программами [22].

Структурированные последовательности, такие как повторяющиеся 01:

X = 01010101010101010101010101010101010101...01

имеют небольшую сложность по KCS. Программа, способная полностью охарактеризовать строку, крайне проста: повторить 01 тысячу раз и остановиться. Последовательность 0 и 1, сформированная путем подбрасывания симметричной

монеты (fair coin) B раз, почти наверняка будет иметь информацию KCS, близкую к B битам. В такой последовательности нет структуры или избыточности,

которой можно воспользоваться для сжатия. Другими словами, последовательность подбрасывания монеты не является сжимаемой. Чтобы передать последовательность без потерь, мы должны записать всю последовательность из нулей и единиц. Сложность KCS будет близка к B битам.

Есть обманчивые строки, которые выглядят случайными и обладающими

большой сложностью по KCS, но это не так. Одной из таких строк является конс

танта Шамперноуна (Champernowne) [23]:

0100011011000001010011100101110111000000010010...

Это число, опубликованное, когда Шамперноун еще был студентом, проходит много тестов на случайность, но имеет низкую сложность KCS. Это хорошо

видно, если записать число в виде сегментированной последовательности:

0 1 00 01 10 11 000 001 010 011 100 101 110 111 0000 0001 0010...

На самом деле это просто список последовательных чисел, записанных

в двоичном формате, и даже для бесконечной последовательности он описывается короткой программой. Для некоторого значения N, определяющего

длину числа, обобщенный алгоритм выглядит очень просто:

От n = 1 до N напечать по порядку все двоичные числа с n бит. Стоп.

1

Несколько дополнительных битов необходимо для обозначения команд программы,

таких как PRINT. Если B исчисляется в миллионах или миллиардах, битами команд

можно перенебречь.

32

Информация: что это такое?

В десятичной форме константа Шамперноуна выглядит следующим образом:

012345678910111213141516171819202122232425262728293031...

Другим примером сложной последовательности является двоичная строка,

описывающая число

π = 3,1415926535897932384626433832795028841971693993751...

в двоичном виде:

π = 11.0010010000111111011010101000100010000101101000110000

1000110100110001001100011001100010100010111000000011011

1000001110011010001...

Строка выглядит случайной. Но поскольку π можно вычислить по простой

формуле

не составит труда сгенерировать π с любой

желаемой точностью при помощи простой компьютерной программы.

Примечание

⍟ Для N, достаточно большого, чтобы достичь желаемой точности, мы можем использовать следующую короткую программу:

S=1;

for n=1:N;

S=S+(-1)n/(2*n+1);

end;

pi=4*S;

PRINT pi;

Формально информация KCS строки X, состоящей из битов B, представляет

собой длину самой маленькой компьютерной программы, которая сгенерирует

строку X и остановится. Длина программы будет зависеть от используемого компьютерного языка. Самая короткая программа для генерации X с использованием языка C++ будет иметь иную длину, чем при использовании языка Python.

Однако, в принципе, всегда найдется транслирующая программа для преобразования кода C++ в код Python. Предположим, что программа для перевода C++

в Python занимает c бит. Если KC++(X) – это сложность KCS для X с использованием

C++, то сложность KCS в Python, KPython(X), не может превышать KC++(X) + c бит.

В случае длинных строк добавление транслирующей компьютерной программы может быть незначительным вкладом в информацию KCS. Во всех случаях разница сложности по KCS между двумя компьютерными языками всегда

может быть ограничена числом c, которое не зависит от описываемого объекта1. Поэтому сложность по KCS является универсальной концепцией, которая

легко переводится с одного компьютерного языка на другой. Мы воспользуемся обозначением [24]:

1

⍟ Точнее, |KC++(X) − KPython(X)| ≤ c.

Измерение информации 33

KPython(X) =c KC++(X),

означающим равенство с точностью до константы c.

Примечание

⍟ Информация KCS часто обозначается нотацией O. Пусть |Y| – это количество битов

в двоичной строке Y. Выражение |Y| = O(e|X|) означает, что при увеличении |X| величина

|Y| асимптотически стремится к кривой, пропорциональной e|X|. В свою очередь, можно

принять O(c + e|X|) = O(e|X|), поскольку e|X| быстро и существенно превысит c.

2.2.1.1. ⍟ Информация KCS в случае беспрефиксных программ

Еще одна иллюстрация сложности KCS представлена на рис. 2.3. На нем изображено двоичное дерево, в котором слева направо растут новые ветви, основанные на разветвлениях с использованием 0 и 1. В некоторых случаях ветвление

заканчивается. Окончания ветвей называются листьями. Последовательности

0 и 1, приводящие к этим окончаниям, записываются в виде двоичных строк

и соответствуют битам, составляющим компьютерную программу. Для любого

серьезного компьютерного языка это дерево будет разветвляться миллиарды

раз и достигнет огромного размера. Тем не менее скромное дерево на рис. 2.3

может служить наглядным примером.

Рис. 2.3 Листья в этом дереве обозначают беспрефиксные компьютерные

программы. Листья, помеченные квадратом, приводят к печати X = 0101010101

и остановке. Самая короткая программа в дереве, которая печатает X, содержит

три бита: 101. Следовательно, информация KCS для X равна K(X) = 3 бита

34

Информация: что это такое?

Компьютерный язык на рис. 2.3 является беспрефиксным, то есть никакая

двоичная строка, соответствующая листу, не может послужить началом другой

программы. Поскольку любой компьютерный язык может быть переведен на

любой другой компьютерный язык, программа на C++ или Python всегда может

быть переведена на беспрефиксный компьютерный язык. Чтобы проиллюстрировать природу беспрефиксного кода, рассмотрим лист с меткой 101 на рис. 2.3.

Программа 101 – это лист в дереве. Для языка без префиксов никакая другая

компьютерная программа не может начинаться с 101. Другими словами, 101

не может быть префиксом любой другой компьютерной программы в дереве.

Рассмотрим далее строку:

Х = 0101010101.

Существует множество программ, которые будут генерировать строку X. Мы

изобразили их на рис. 2.3 в виде листьев с квадратами: . Даны четыре такие

программы. Поскольку все листья не показаны, в дереве могут быть другие,

более глубокие ветви. Четырехбитовая программа 1110 выводит X и может соответствовать алгоритму наподобие следующего:

1110 → Напечатать 0101 два раза и остановиться.

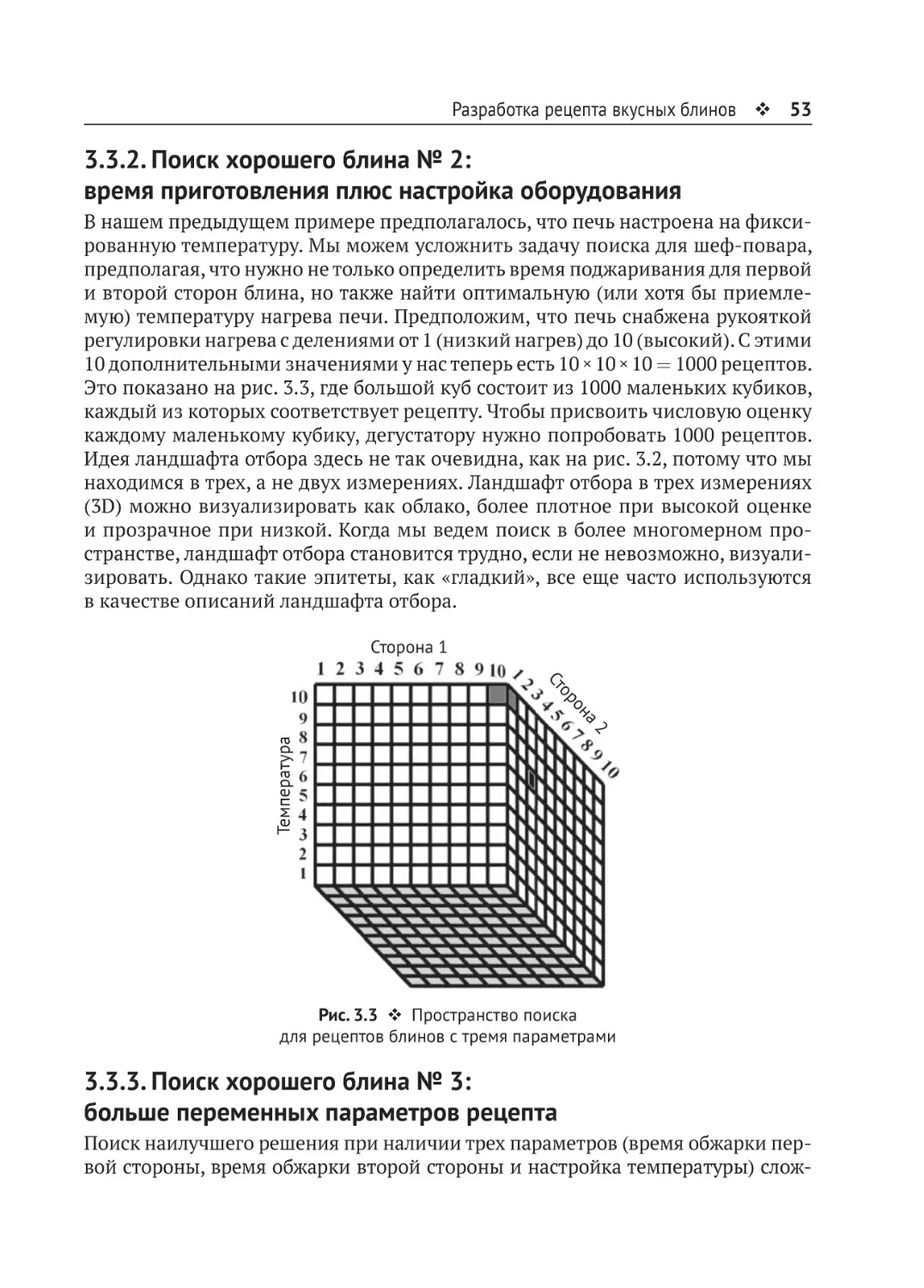

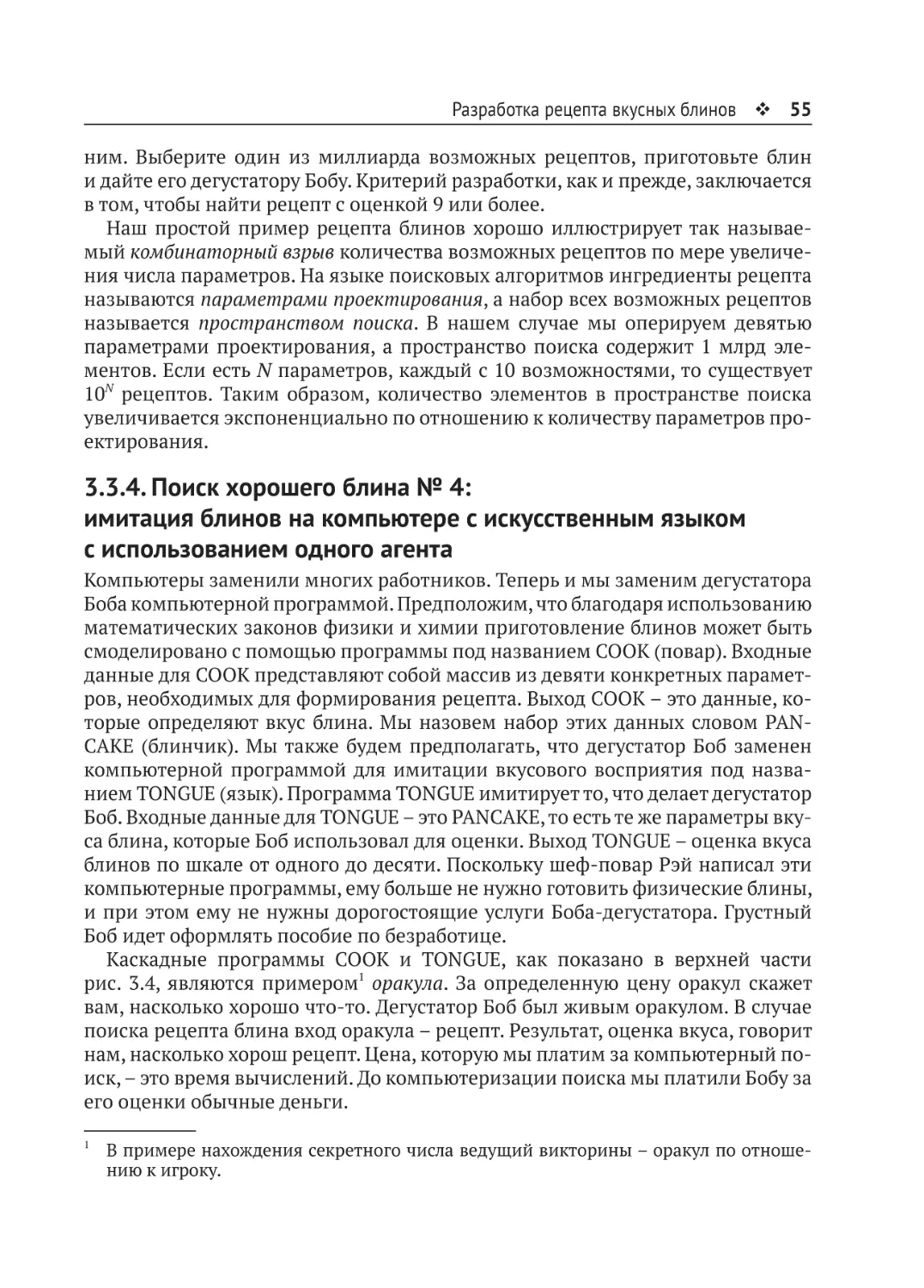

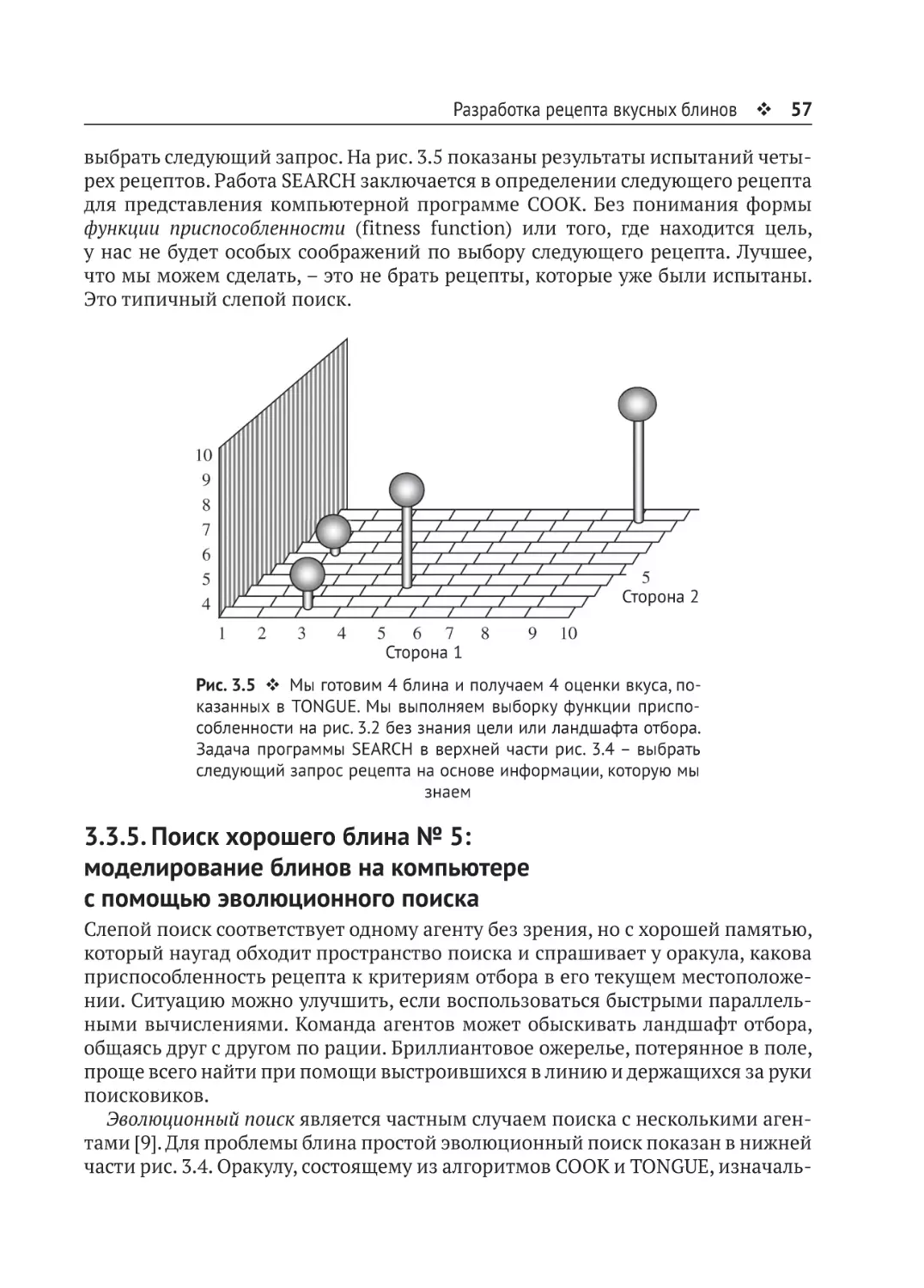

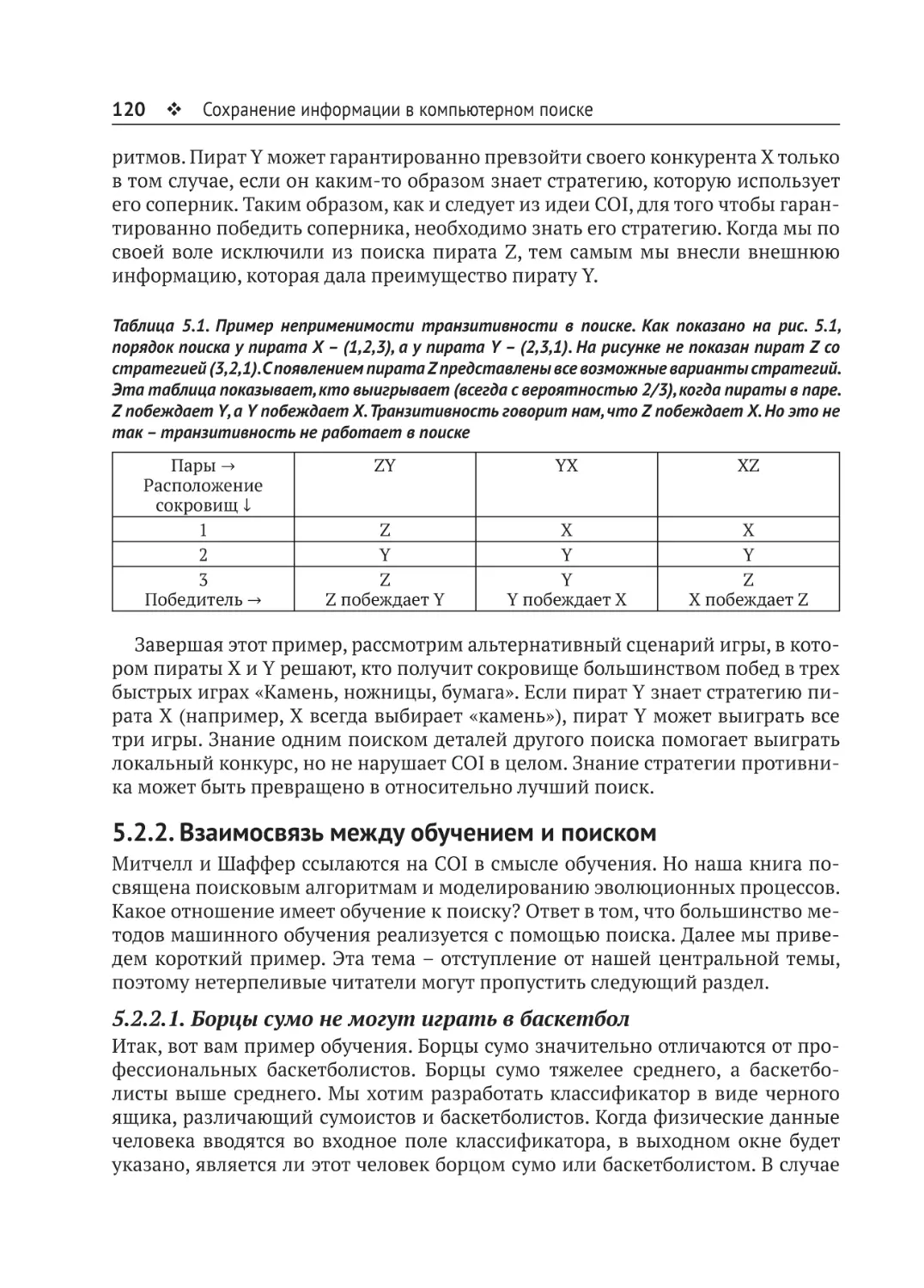

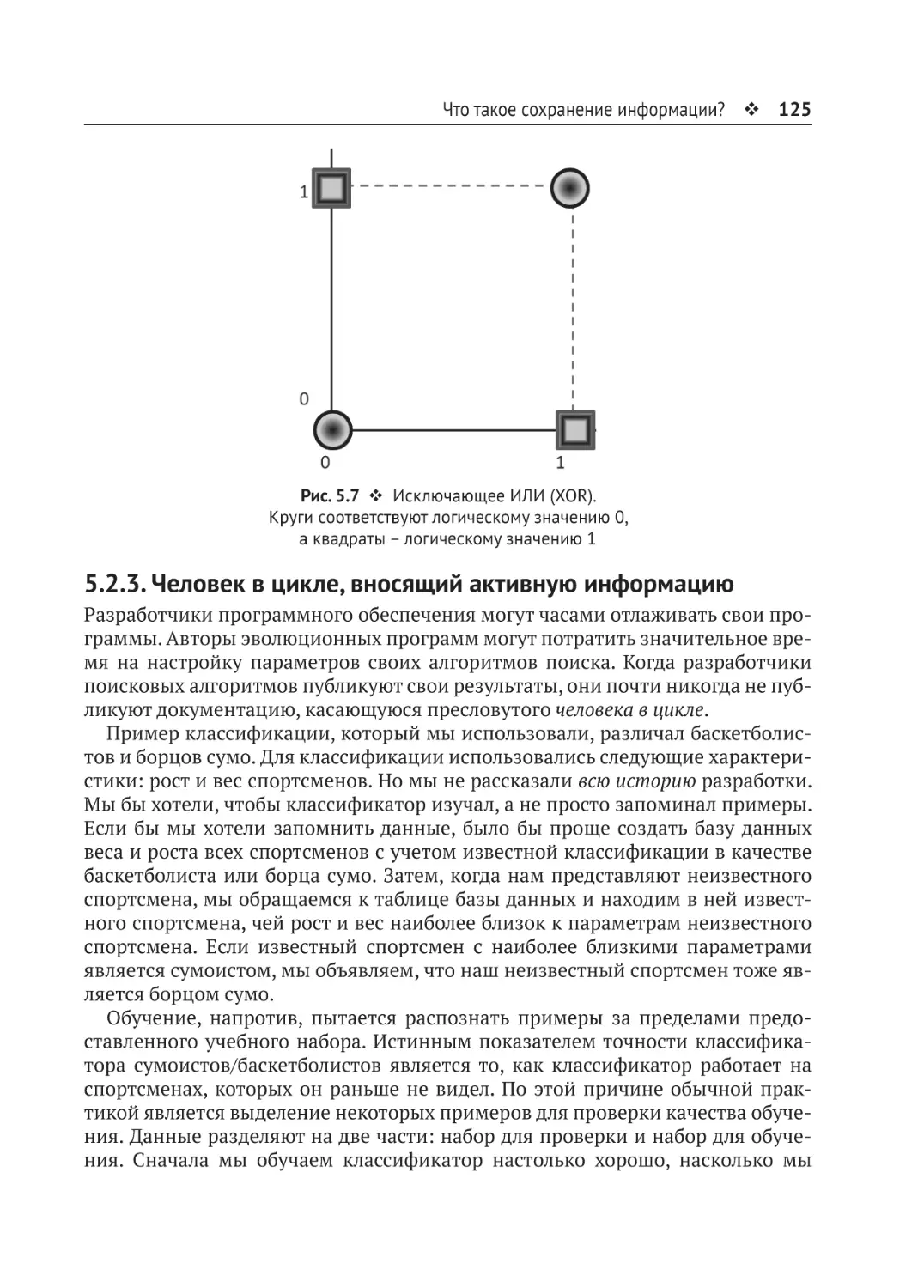

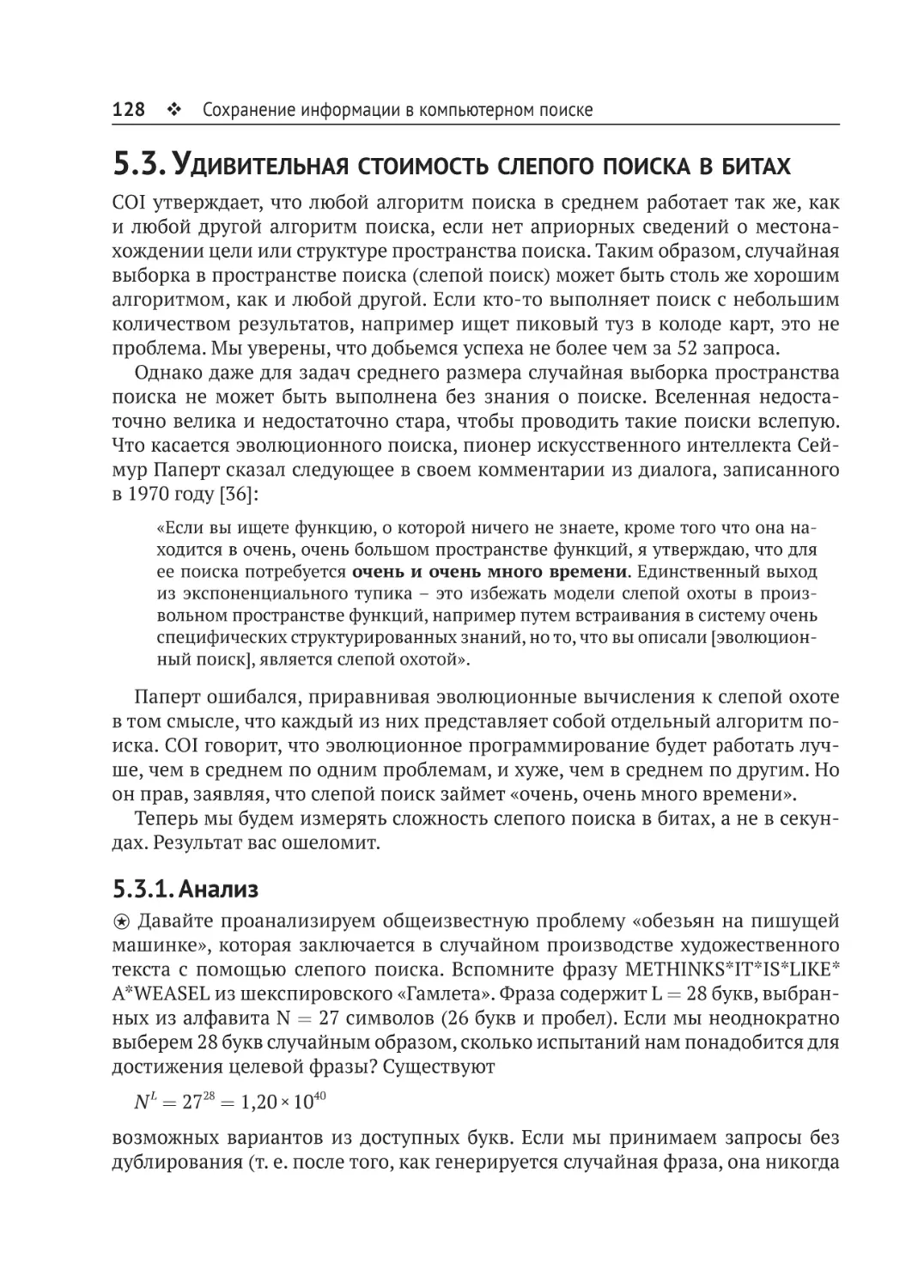

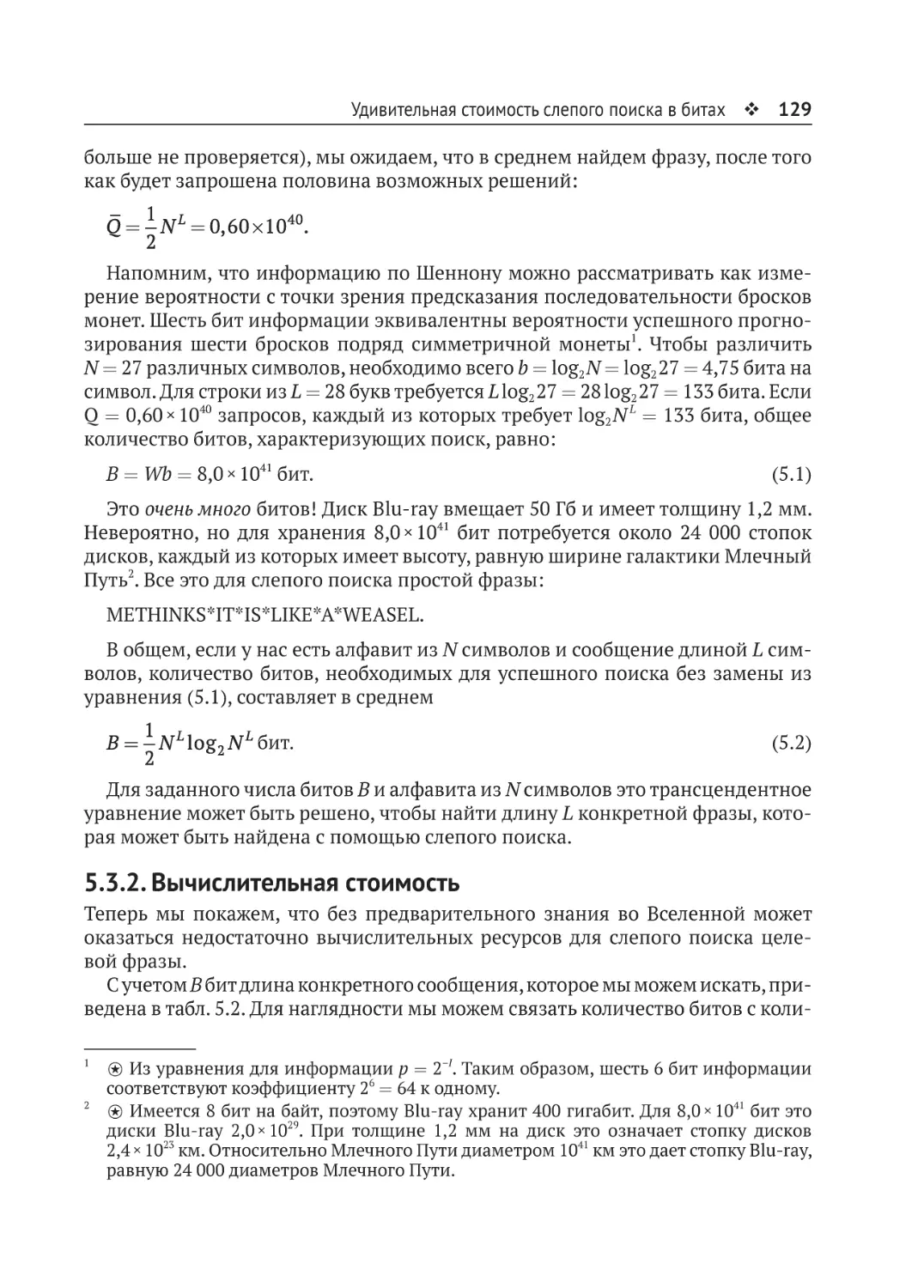

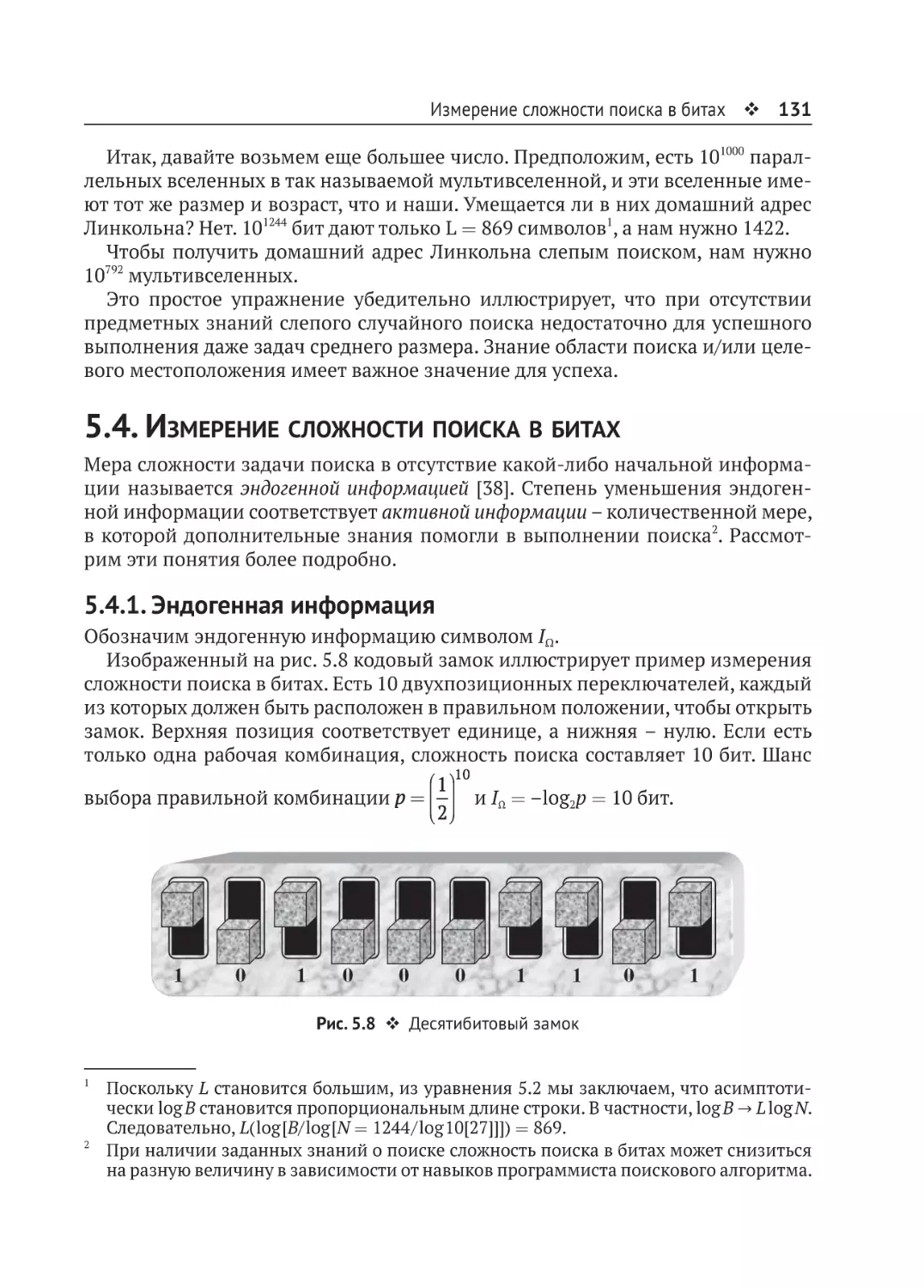

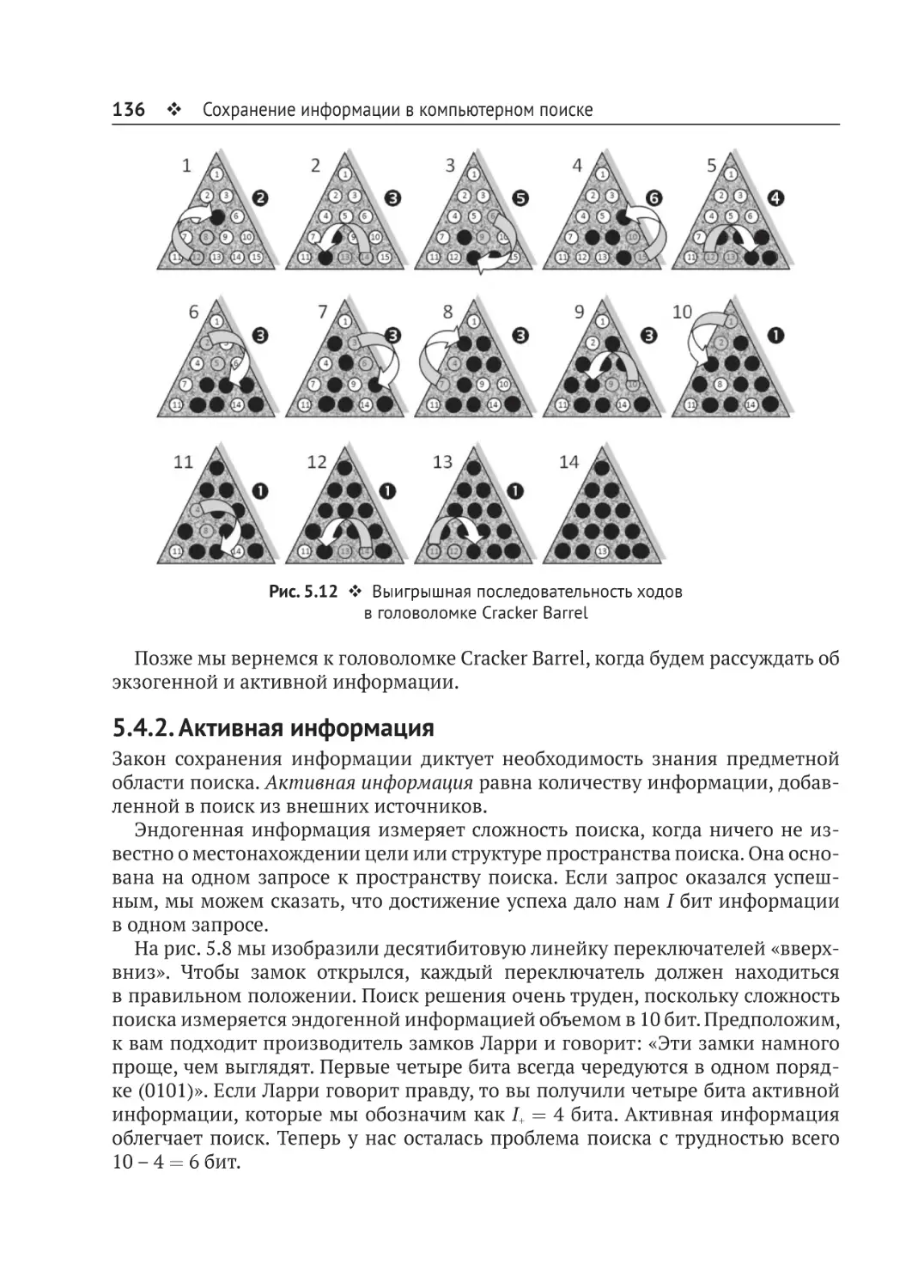

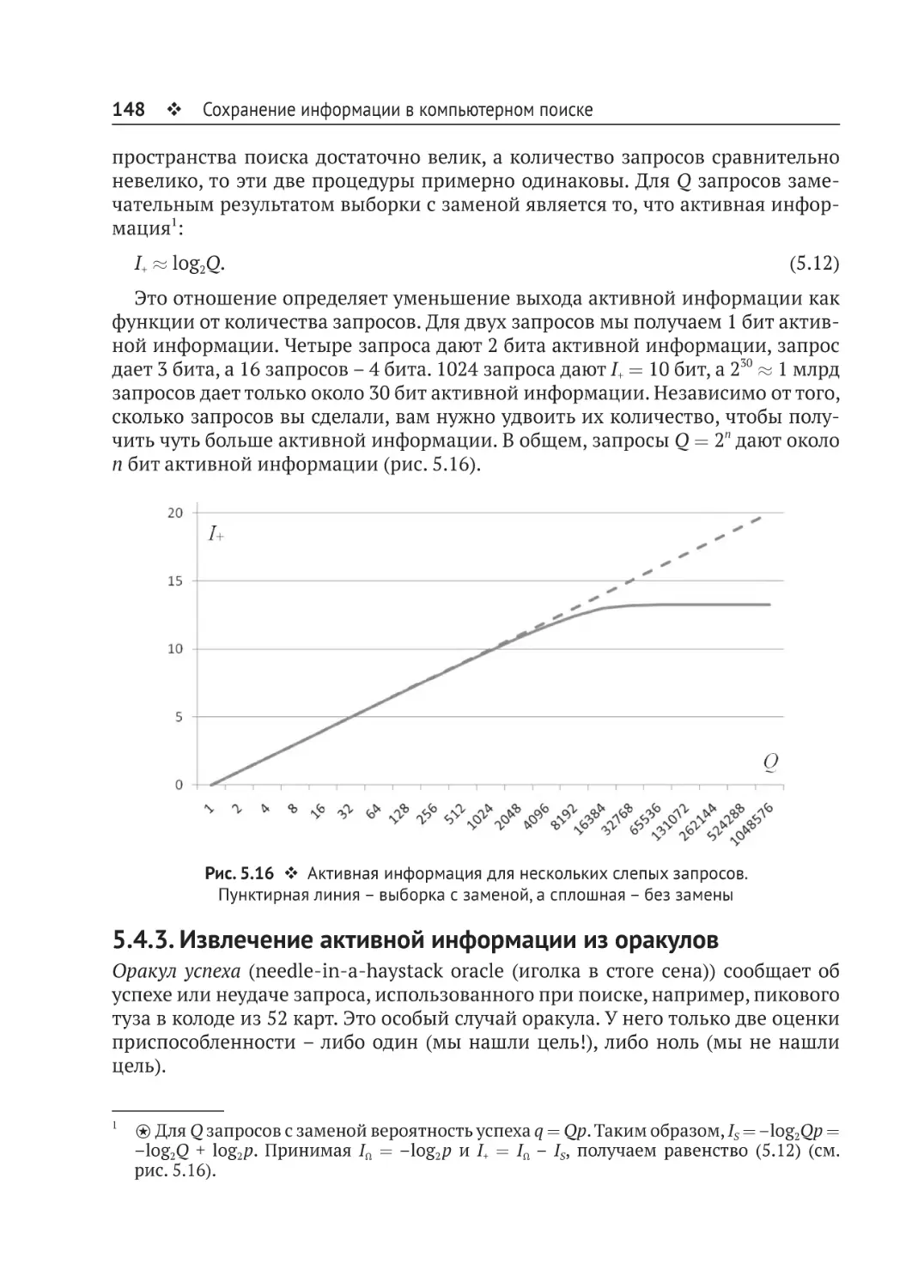

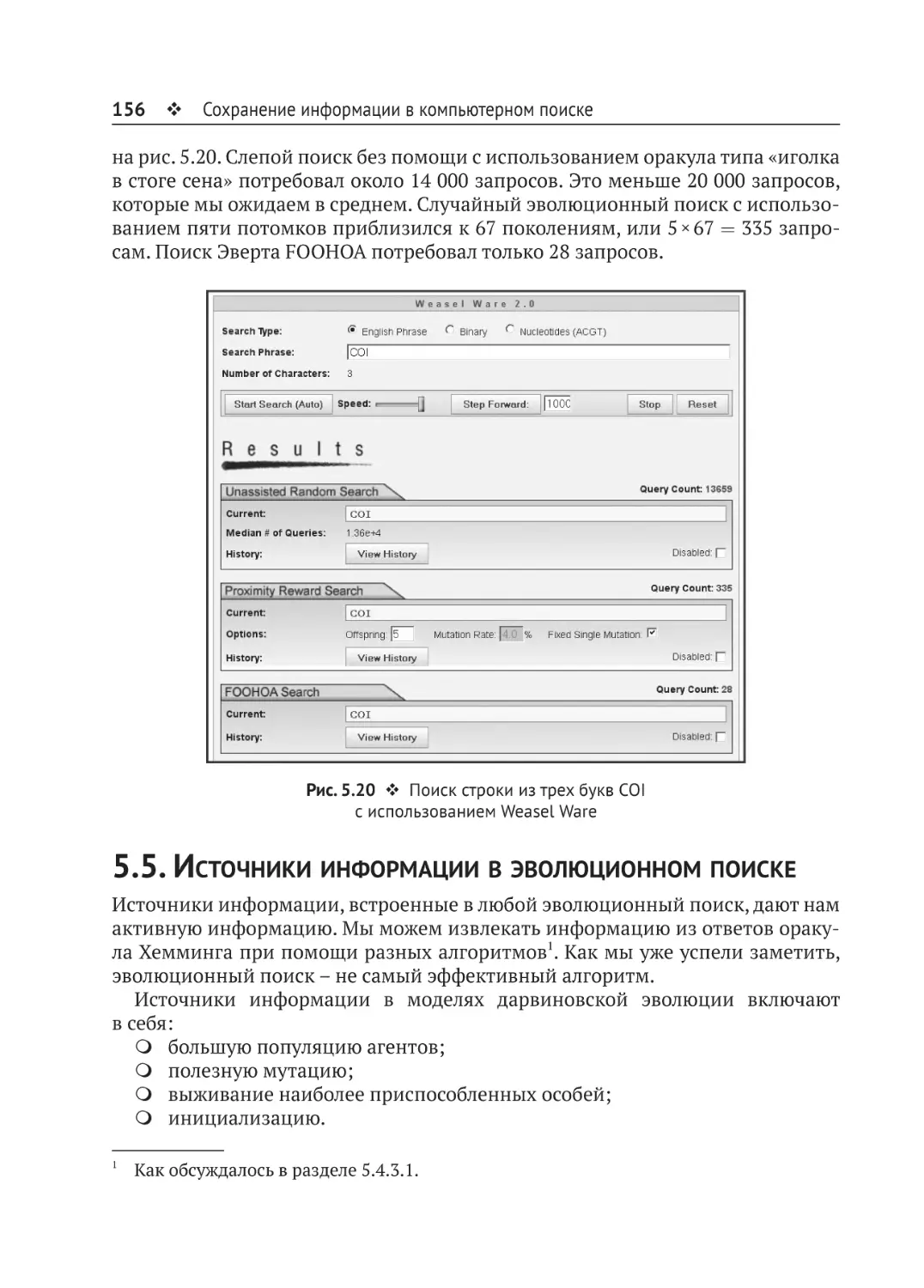

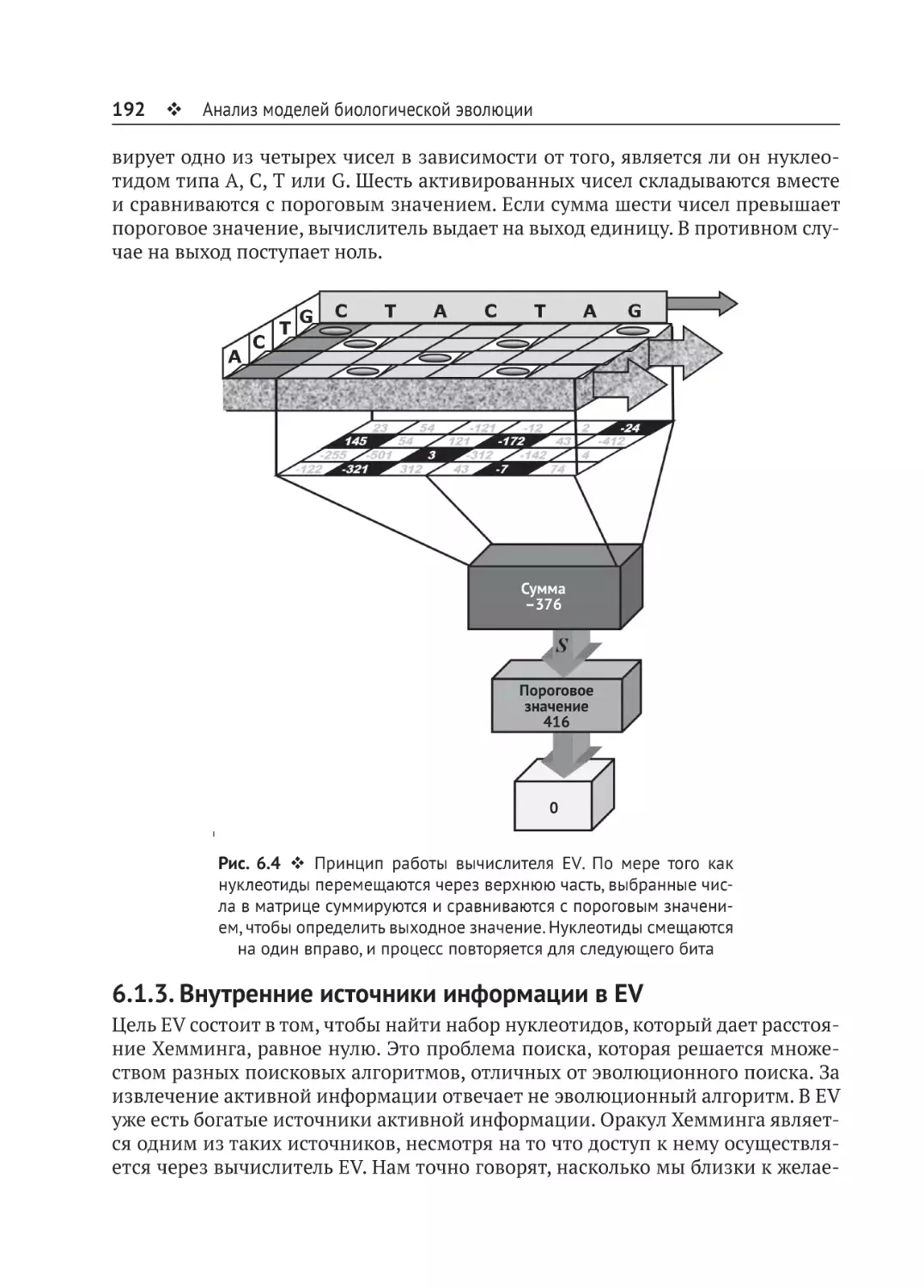

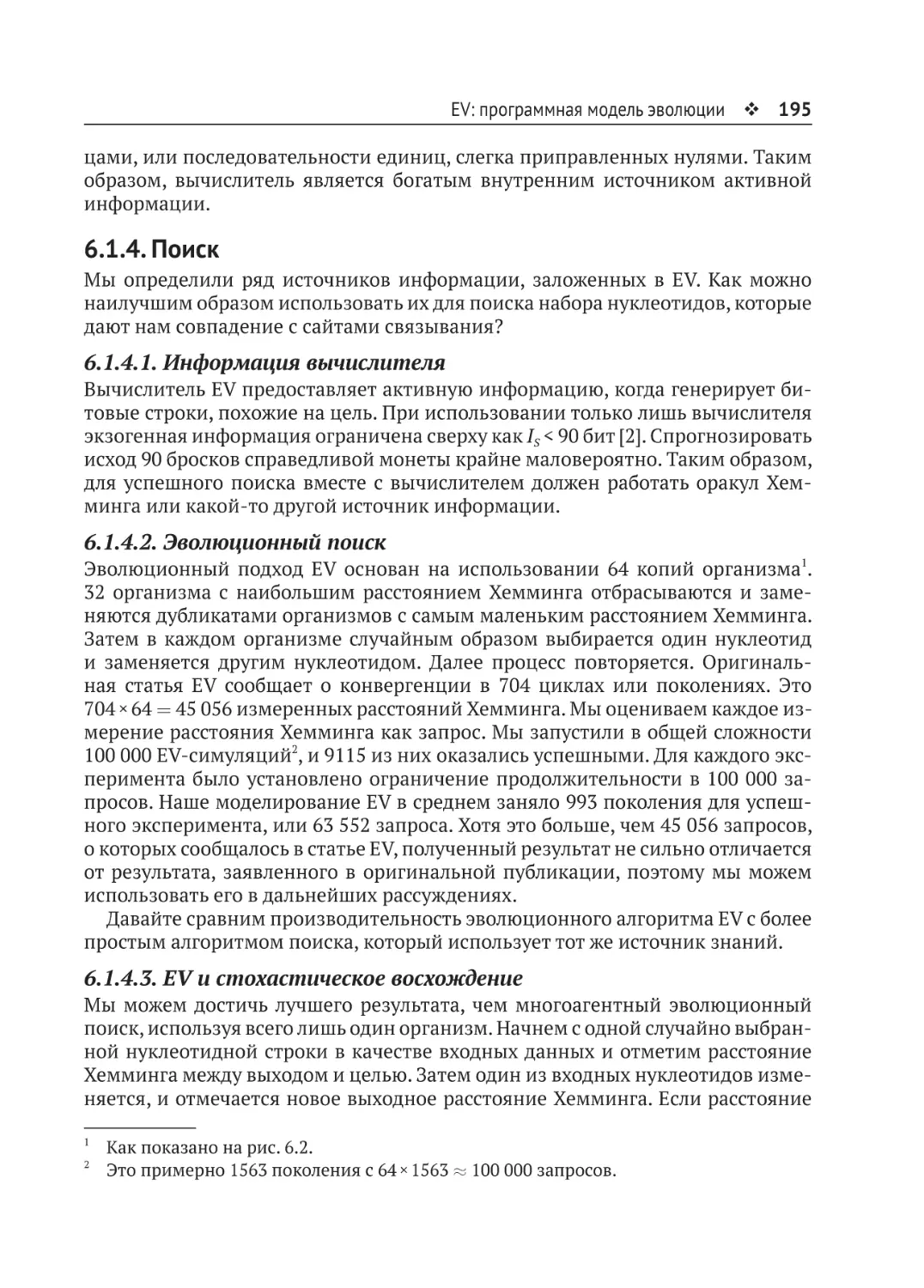

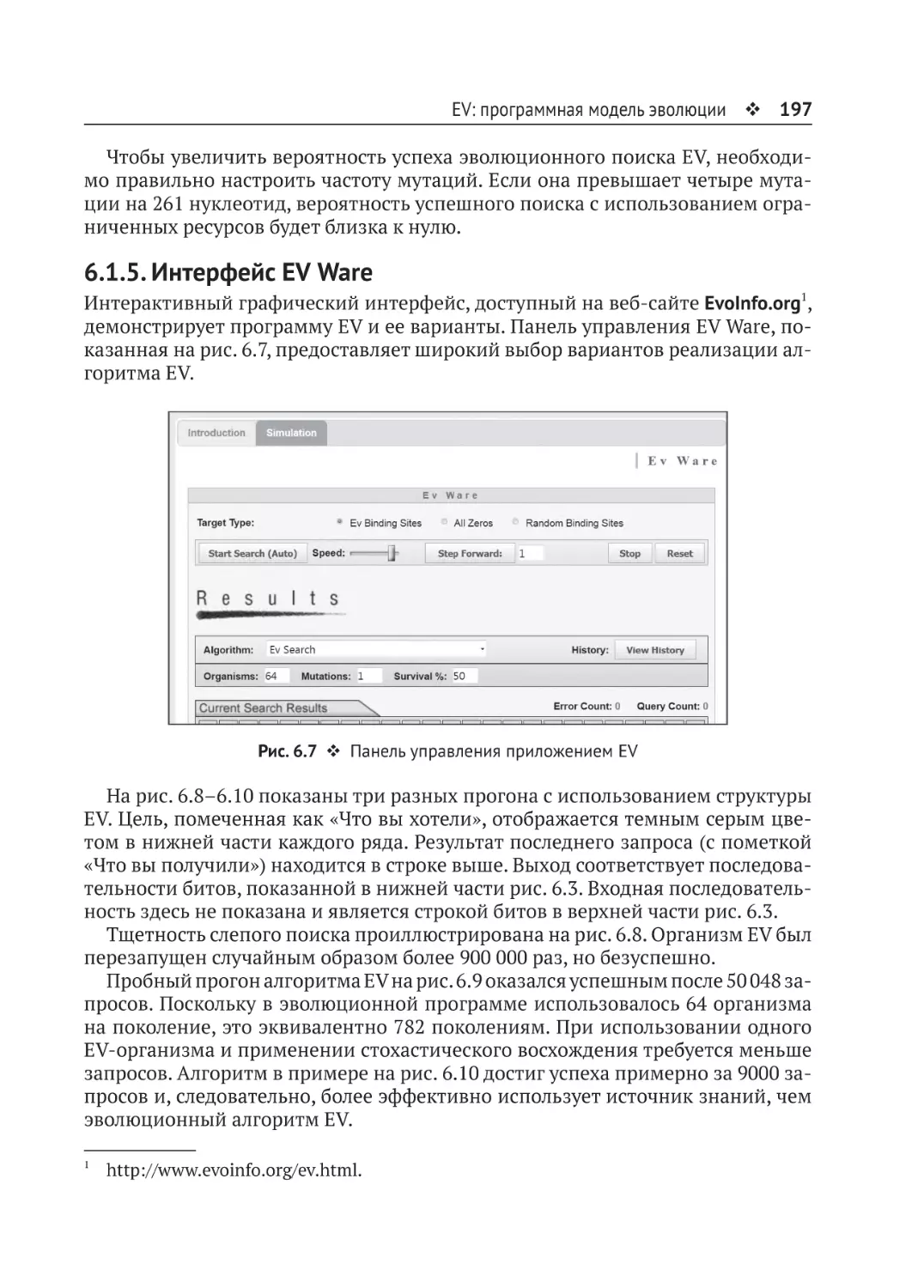

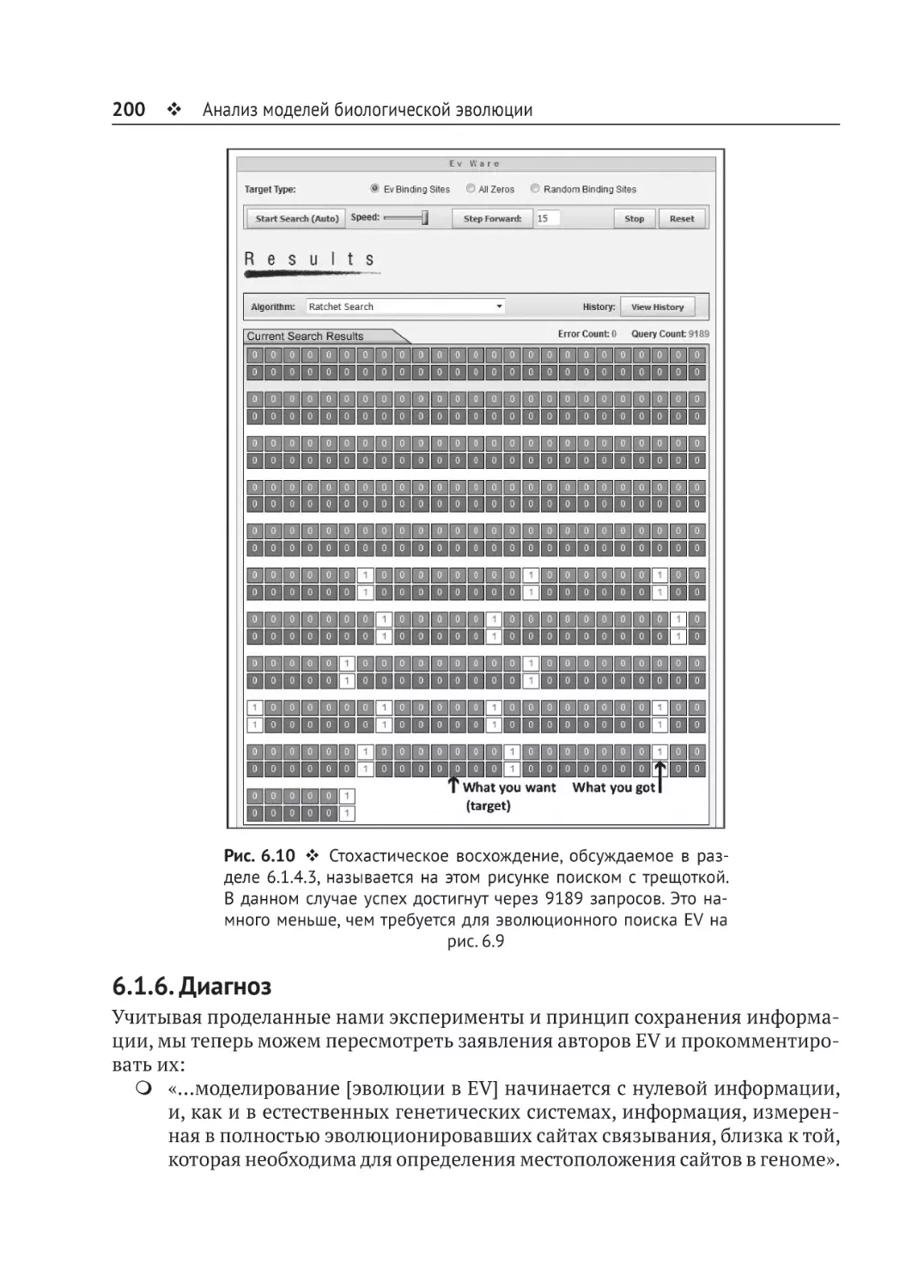

Примечание