Текст

БИБЛИОТЕНКА ИНОСТРАННЫХ КНИГ ДЛЯ ЭКОНОМИСТОВ И СТАТИСТИКОВ

JOHN D. HEY

AN INTRODUCTION

TO BAYESIAN STATISTICAL

INFERENCE

FOR ECONOMISTS

DATA IN DOUBT

MARTIN ROBERTSON

ДЖ. ХЕЙ

ВВЕДЕНИЕ В МЕТОДЫ

БАЙЕСОВСКОГО

СТАТИСТИЧЕСКОГО ВЫВОДА

Перевод с английского А. А. РЫБКИНА

МОСКВА

"ФИНАНСЫ И СТАТИСТИКА"

1987

ББК 22.172

Х35

БИБЛИОТЕЧКА ИНОСТРАННЫХ КНИГ

ДЛЯ ЭКОНОМИСТОВ И СТАТИСТИКОВ

С 1980 г. вышли из печати книги:

Н. Хастингс, Дж. Пикок. Справочник по статистическим

распределениям. 1980.

А. Гильберт. Как работать с матрицами. 1981.

М. Кен дел. Временные ряды. 1981.

Ю. К ю н. Описательная и индуктивная статистика. 1981.

A. Эренберг. Анализ и интерпретация статистических данных. 1981.

П. Мюллер, П. Н о й м а н, Р. Шторм. Таблицы по математической

статистике. 1982.

Г. К и м б л. Как правильно пользоваться статистикой. 1982.

Э. Ф е р с т е р, Б. Р е н ц. Методы корреляционного и регрессионного

анализа. 1983,

М. Холлендер, Д. Вулф. Непараметрические методы статистики. 1983.

И. Л и к е ш, И. Л я г а. Основные таблицы математической статистики.

1985.

Р. Джессе н. Методы статистических обследований. 1985.

X. Ар е не, Ю. Л ё йте р. Многомерный дисперсионный анализ. 1985.

К. Льюис. Методы прогнозирования экономических показателей. 1986.

И. Вучков, Л. Бояджиева, Е. Солаков. Прикладной линейный

регрессионный анализ. 1987.

Подготавливаются к изданию:

B. П л ю т а. Многомерный сравнительный анализ в эконометрическом

моделировании.

П. Б л а г у ш. Факторный анализ с обобщениями.

Редколлегия серии:

В. И. Данилов-Данильян, Е. 3. Демиденко, В. М. Иванова, А. В. Павлю-

ков, Г. Г. Пирогов, А. А. Рыбкин, Е. М. Четыркин, Р. М. Энтоа.

1702060000-053 ^ п © John D' НеУ' 1983

102—87 © Перевод на русский язык, вступительная статья,

Ф 1987

10287 © р ру ,

010@1)—87 «Финансы и статистика», 1987

О БАЙЕСОВСКОМ ПОДХОДЕ

И СУБЪЕКТИВНЫХ ВЕРОЯТНОСТЯХ

Перед вами учебное пособие по теории статистического вывода,

обладающее тремя отличительными особенностями. Во-первых, оно

рассчитано на тех, для кого статистика станет средством при проведении

прикладных исследований (главным образом, на экономистов).

Во-вторых, оно написано просто, поскольку адресовано читателю, имеющему

минимальную предварительную подготовку. В-третьих,

методологической основой предлагаемого курса является так называемый

байесовский подход, уже давно развиваемый в математической статистике в

качестве альтернативы классическому.

Число классических руководств по теории статистического вывода

измеряется в настоящее время уже многими десятками. В основном это

книги, написанные с целью популяризации, в то время как серьезные

монографические исследования становятся более специальными и

встречаются все реже. Однако такое соотношение нельзя

распространить на исследования, ведущиеся в рамках байесовского подхода, где

монографические работы, безусловно, преобладают. Казалось бы,

напрашивается естественный вывод о большей продуктивности

байесовского подхода. Но получаемые с его помощью результаты в принципе

переводятся на язык классической статистики, и поэтому многие

склонны говорить не о продуктивности байесовского подхода, а о его

излишней усложненности. На вопрос слушателя, в чем состоит байесовский

подход в статистике, лектор, завершающий свой курс, отвечает

примерно следующее: «Это попытка найти другой способ обоснования понятия

вероятности, нежели тот частотный, о котором я говорил, или

аксиоматический, предложенный А. Н. Колмогоровым и употребляемый при

более глубоком изложении предмета. Попытка, вообще говоря,

сомнительная, ибо основана она на понятии субъективной вероятности, т. е.

ориентирована на изучение не столько объективной реальности,

сколько представлений отдельного индивида о ней. К тому же не простого

индивида, а мыслящего не иначе как в вероятностных терминах.

Подобный подход связан с дополнительными трудностями, на преодоление

которых обычно уходят все силы исследователей байесовского

направления. Для практика разницы между байесовским и классическим

подходами почти нет. Числовые оценки будут получены те же. Но поинте-

5

ресоваться работами байесовского направления при случае полезно.

Интерпретация результатов у них иная, иногда более убедительная».

Серьезные занятия байесовской статистикой по общему признанию

были доступны лишь узкому кругу «посвященных». Байесовские курсы

теории статистического вывода были написаны, но они вовсе не

предназначались для первоначального чтения. От читателя требовалась

некоторая математическая изощренность, да к тому же и хорошая

методологическая подготовка — без нее невозможно обрести нужную свободу

в искусстве интерпретации. Построить начальный курс теории

статистического вывода сразу же на основе байесовского подхода казалось

невозможным. Дж. Хей такую задачу решил. Вот почему, обладая

тремя перечисленными выше особенностями, эта книга в момент ее

выхода в свет была единственной в своем роде.

Байесовский подход применяется в математической статистике и в

теории принятия решений. Его наименование происходит от одного из

базовых утверждений теории вероятностей — правила (или теоремы)

Байеса. Формулируется правило чрезвычайно просто (см. гл. 2 данной

книги) и позволяет связать между собой условные и безусловные

вероятности. Эта связь была установлена английским математиком

Томасом Байесом (или Бейесом) в середине XVIII в. и, как впоследствии

оказалось, может быть положена в основу ряда базовых процедур

математической статистики, в частности теории статистического вывода.

Байесовский подход можно рассматривать в рамках

аксиоматической теории вероятности. Тогда вычленяется определенный круг задач,

для решения которых он оказывается удобным средством. Но можно

воспринимать байесовский подход шире и пытаться распространить

его на основания математической статистики, вводя в качестве

базового понятие субъективной вероятности, как это сделано в книге

Дж. Хея. Именно в этом случае и возникают основные противоречия

между классическим и байесовским подходами.

Как это нередко бывает в науке, противоречия здесь во многом

кажущиеся, и объясняются они главным образом несоответствием

притязаний, связанных с разработкой теории, с одной стороны, и

содержания решаемых с ее помощью задач — с другой.

Классический подход сформировался как средство анализа хорошо

описанных и повторяющихся ситуаций, максимально приближенных к

модельным схемам. Вначале это были разнообразные азартные игры:

орлянка, кости, рулетка, карты. В каждой из таких игр (сложные

карточные игры при этом не рассматриваются) сам «механизм

случайностей» абсолютно ясен. Если, например, нам вручили обычную монету

и попросили выяснить, является ли она «правильной», т. е. выпадают ли

герб и решетка при ее подбрасывании с одинаковой частотой, то мы

можем провести достаточно длинную серию испытаний и по ее

результатам с помощью методов теории статистического вывода ответить на

поставленный вопрос. В рамках обоих конкурирующих подходов

выводы будут получены по сути своей одинаковые и различаются они лишь

6

формой и некоторыми особенностями интерпретации. Принципиальных

преимуществ у байесовского подхода при этом обнаружить не удается.

Но представьте себе, что игра в орлянку — привычное для некоего

индивида занятие и тот овладел определенным навыком распознавать

по внешним свойствам монеты ее смещенность «в пользу» герба или

решетки. Он все равно проведет с монетой серию испытаний и в своем

окончательном выводе, т. е. в своей апостериорной оценке, учтет как

априорное суждение, сформулированное до испытаний, так и

результаты проведенных экспериментов. Мы сформулировали сейчас

простейшую и наиболее типичную задачу, требующую для своего решения

байесовского подхода, основанного на понятии субъективной

вероятности. До начала экспериментов наш индивид по разнообразным

известным ему из предыдущего опыта признакам оценил свойства

предложенной монеты и сформулировал свой априорный вывод в вероятностных

терминах, т. е. с помощью понятия субъективных вероятностей. Затем

он может воспользоваться процедурами байесовского вывода и

объединить априорные представления с информацией об испытаниях, чтобы

получить оценку своих апостериорных представлений.

Итак, байесовский подход, опирающийся на понятие субъективной

вероятности, не умозрителен, он необходим для решения вполне

конкретных задач, которые решить иначе было бы нелегко. Само понятие

субъективной вероятности не таит в себе какого-либо подрыва

материалистических идей, а тот, кто им пользуется, совсем не обязательно

призывает к научному признанию субъективистских мировоззренческих

концепций. Более того, если избегать неоправданных спекуляций и

пользоваться понятием субъективной вероятности достаточно строго,

мы можем продемонстрировать весьма смелый и заведомо

материалистический подход к анализу процессов познания и обучения, в которых

непосредственно участвует сознание. В конечном счете речь идет об

извечной проблеме адекватности теории и реальности в свете

поставленной задачи. Материалист-метафизик пугается слова «субъективный» в

сочетании с термином «вероятность», поскольку не до конца освоился

с диалектикой процесса познания; поэтому видит свою роль главным

образом в твердом проведении в жизнь той линии, которая наиболее

естественным образом вытекает из законов, уже открытых теорией.

Он забывает при этом, что сами законы — продукт сознания, и элемент

субъективизма в любой теории неизбежен. Мировоззренческая робость

обычно удивительным образом сочетается с безоглядной научной

смелостью, с поиском всеобщих решений и подходов, применимых всегда

и повсеместно. Вот почему противник классического подхода вызывает

порой большее доверие, нежели сторонник байесовского, несмотря

на то, что в обеих этих ролях выступает, как правило, одно и то же

лицо. То же самое можно сказать о противниках байесовского подхода и

сторонниках классического. Всегда существует такой уровень

обобщения, с которого любая эмпирически проверяемая теория

воспринимается не как «адекватное» объяснение реальности, а как одно из средств,

7

как более или менее сложный инструмент для ее изучения. И

поднявшись на этот уровень, мы должны по-иному взглянуть на те построения

и выводы, которыми довольно уверенно пользовались до этого.

Придется задуматься об относительности теоретических абсолютов и

вспомнить, что теория должна быть адекватна реальности не вообще и не с

какой-то точностью, а в контексте конкретно поставленных задач.

Сторонники классического подхода, которые не являются при этом

непримиримыми противниками байесовского, обычно говорят:

байесовский подход хорош при малых выборках. Эту фразу можно

произнести и с одобрением, и с некоторым сожалением. В зависимости от

интонации она будет нести разную смысловую нагрузку. Можно сказать

также, что классический подход хорош при больших выборках, и это

тоже будет близким к истине.

Байесовский и классический подходы к теории статистического

вывода будут развиваться параллельно, ибо реально существуют задачи,

для решения которых какой-то из них более приспособлен.

В книге Дж. Хея есть методологические издержки, связанные с бе-

заговорочной приверженностью автора к байесовскому подходу в

качестве «единственно правильной» альтернативы классическому. Это

следует иметь в виду при ее чтении. Тем не менее книга является весьма

удачным введением в прикладную статистику. Овладев с ее помощью

основными понятиями теории статистического вывода, читатель сможет

довольно успешно продолжить изучение этой теории с помощью

других, более подробных и более глубоких руководств. Нужно выработать

при этом привычку воспринимать прикладные теории как

инструментарий, имеющий определенную сферу применения.

Следует осторожно относиться к ощущению предельной простоты и

естественности байесовского подхода, которое возникает при чтении

книги. Дж. Хей рассматривает, например, задачу, связанную с

выяснением шансов социал-демократической партии на выборах в

северовосточном округе Бристоля. С этой целью проводится опрос

общественного мнения среди избирателей округа на основе случайной выборки.

С увеличением объема выборки растет уверенность в полученных

оценках, что вполне отвечает интуитивным представлениям. Но при этом

ни разу не упоминается объем всей совокупности, из которой

осуществляется выборка, т. е. объем соответствующей генеральной

совокупности, как говорят в классической статистике. Ясно, что чем меньшая

часть совокупности будет обследована, тем с большей вероятностью мы

можем ошибиться в своих ожиданиях и принять за близкую к

истинной доле поддерживающих социал-демократов величину, достаточно

от нее удаленную. Увлечение субъективной стороной процесса

оценивания приводит к тому, что Дж. Хей интересуется объемом

совокупности в сопоставлении с объемом выборки лишь в связи с вопросами,

далеко не первостепенными. Например, обязательно ли проводить

выборку элементов с возвращениями, чтобы сохранить равновероятность при

извлечении каждого из них. Есть вопросы гораздо более существенные.

8

Например, если бы речь шла об избирателях во всей Англии, то

выборки объемом в 30, 100, 500 человек имели бы такую же

информативную ценность, что и для данного округа, или нет? Такие вопросы не

обсуждаются, и это не случайно. Они для байесовского подхода менее

органичны, чем для классического.

Байесовский подход действительно упрощает изложение основных

положений теории статистического вывода по сравнению с

классическим. Он позволяет развить некоторые оригинальные и весьма

полезные направления анализа. Но при этом он создает серьезные

препятствия при решении (а нередко и при постановке!) задач, для классической

статистики вполне естественных. Как бы ни казалось при первом

знакомстве, что интерпретация понятия «доверительного интервала» в

классической статистике сложна и трудно воспринимается, для

глубокого понимания сути статистических методов она нужна.

Часто обращают внимание на то (как это делает в своей книге и

Дж. Хей), что байесовский подход более приспособлен к решению задач,

возникающих в социальных науках, в то время как классический

подход отвечает требованиям естественнонаучных теорий. Это так,

потому что элемент субъективности в общественных науках проявляется.

Объективно в социальных исследованиях должно быть меньше

рутинного, шаблонного, а преобладать то, что обычно обозначают

термином ad hoc. Именно для исследования ad hoc, максимально

учитывающего специфику данной задачи, байесовский подход может

применяться успешнее классического. Это довольно ярко показал в своей книге

Э. Лимер (см. : Лимер Э. Статистический анализ неэкспериментальных

данных. Выбор формы связи. —М.: Финансы и статистика, 1983).

Книга Дж. Хея адресована, как мы уже отмечали, начинающим. Это

вводный курс. Предполагается минимум начальных сведений у

читателя. Достаточно строг отбор материала — ничего лишнего, по

возможности без деталей. Некоторая избыточность текста—существенный

психологический прием, активизирующий с помощью повторов

материал, изложенный ранее. Таким образом, чтение этой книги

превращается в своего рода программированный процесс обучения. Кроме

повторения и закрепления пройденного материала, читатель получает

возможность воспринимать менее насыщенный информацией текст;

мера здесь, как известно, необходима. Нарочитая бедность языка — тоже

своего рода средство обучения, поскольку языковое разнообразие

обычно вступает в противоречие с точностью и однозначностью

формулировок. Местами автор был столь последователен в своих языковых

привязанностях, что при переводе оказалось просто невозможным сохранить

этот, вероятно, вполне оправданный колорит.

Книга в первую очередь адресована преподавателям статистики

вузов. Она будет с пользой прочитана и студентами, и теми, кто считает,

что уже давно освоил теорию статистического вывода.

А. А. Рывкин

ПРЕДИСЛОВИЕ

На протяжении ряда лет я читаю вводный курс статистики и

эконометрии студентам, изучающим экономику. Для многих преподавателей

подобная деятельность связана с постоянным поиском наиболее

естественного и потому не требующего чрезмерных усилий от слушателей

способа изложения достаточно трудного для восприятия материала.

Ради этого перекраивают курсы, комбинируют их на основе имеющихся

руководств и пишут новые. Однако улучшения оказываются

незначительными, ибо не затрагивают существа этой «фундаментальной

проблемы». Тем не менее попытки продолжаются. Я тоже был занят этим

малоперспективным делом, пока около трех лет назад не осознал

окончательно, в чем кроется причина наших неудач.

Основным недостатком большинства курсов эконометрии и

статистики является применение в них классического подхода к получению

статистического вывода. Студентам такой подход кажется неестественным

и интуитивно неоправданным, поскольку не согласуется с тем обычным

способом, каким люди (неважно, статистики они или нет)

ассимилируют информацию в повседневной жизни. На практике каждый

постоянно пользуется (хотя, может быть, и неосознанно) вероятностной

трактовкой теорий, гипотез и фактов, которые либо вызывают сомнения,

либо являются неоцределенными по своей сути. Тогда возникает

необходимость пересматривать свои оценки в свете новой информации.

Решить эти задачи позволяет байесовский подход к статистике.

Впервые я прочитал байесовский курс статистики два года назад и^

естественно, столкнулся вначале с некоторыми трудностями, хотя надо

признать, что они не были слишком серьезными. Зато я убедился, что

«фундаментальной проблемы» больше нет. (Правда, остались

проблемы со студентами, уже частично знакомыми с классическим курсом,

которым было нелегко отказаться от традиционного стиля мышления.)

10

Сейчас исходя из опыта предыдущих лет я могу сказать, что

байесовский подход наиболее удобен для восприятия. (Это вовсе не означает,

что он позволяет преодолеть все трудности. Однако те из них, которые

остаются, как правило, общие для всех подходов.)

Единственным реальным препятствием при изучении байесовского

курса статистики оказалось отсутствие соответствующего учебного

пособия, к которому студенты могли бы обращаться в процессе

самостоятельной работы. Вот почему написана эта книга. Первый ее вариант

использован при чтении учебных курсов в Йоркском университете в

1981—1983 гг. Затем он был существенно переработан с учетом

пожеланий и предложений, полученных от моих студентов и коллег. Им я

выражаю свою искреннюю признательность.

Джон Д. Хей,

Йорк, январь 1983 г.

ГЛАВА

I

ВВЕДЕНИЕ

Статистика разрабатывает инструментарий, помогающий

принимать решения в условиях неопределенности. Эта книга посвящена

статистике и адресована в первую очередь экономистам. Ее цель —

показать, как статистика может помочь экономисту принимать решения в

условиях неопределенности.

Нет необходимости доказывать, что все экономические теории,

отчеты о реальной хозяйственной деятельности и прогнозы, равно как

и рекомендации в отношении экономической политики, всегда содержат

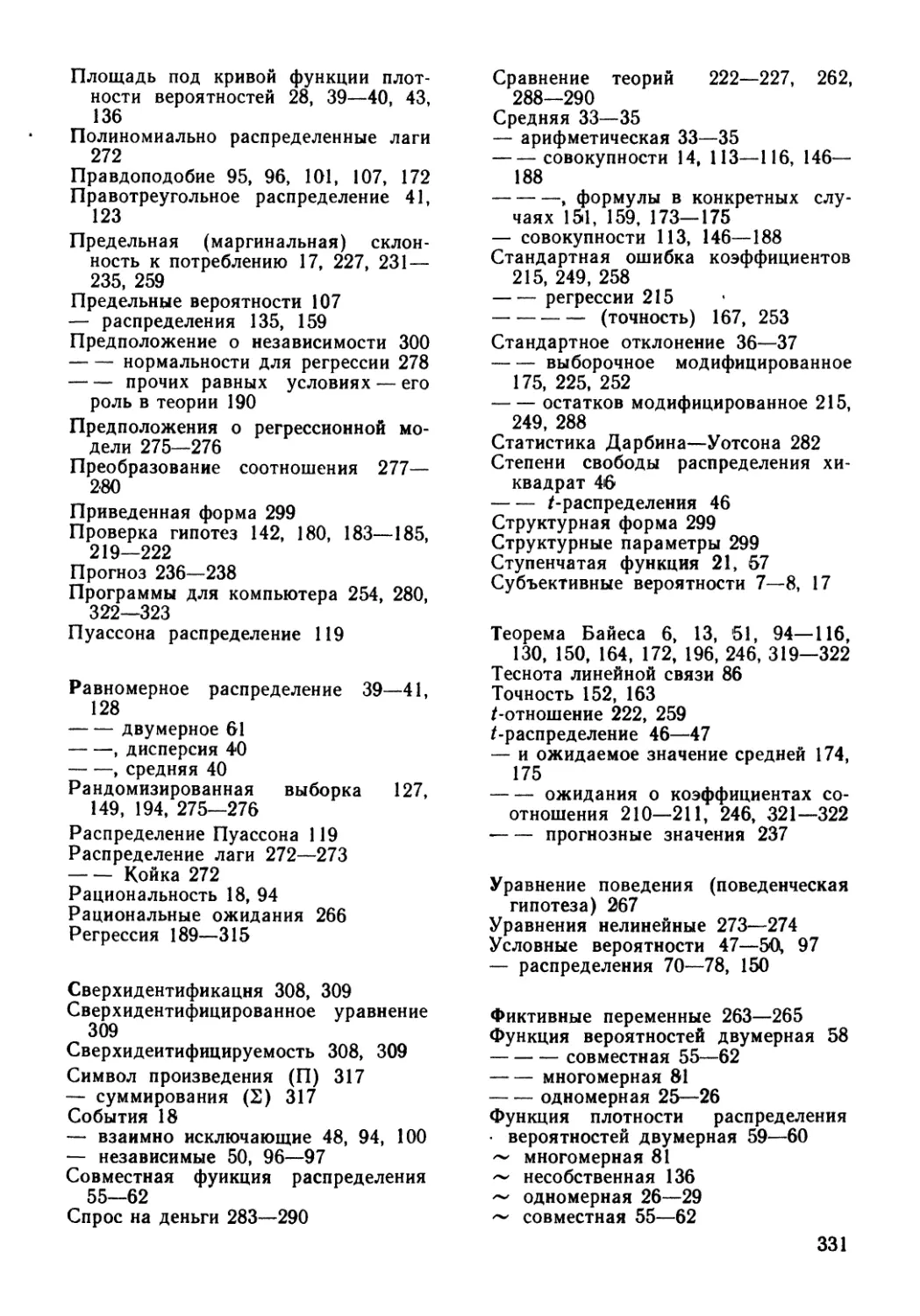

ту или иную долю неопределенности. Естественно, что уровень

неопределенности меняется в зависимости от сферы ее проявления.

Например, агрегированные потребительские расходы весьма устойчивы и

легко объяснимы. Агрегированным инвестиционным расходам

свойственна большая неопределенность и поэтому с достаточной полнотой

объяснить их вариабельность не удается. Руководствуясь неким общим

правилом, в соответствии с которым приложение больших усилий

позволяет получить больше информации, многие экономисты стремятся

сузить область своих профессиональных интересов, ограничить ее и

тем самым уменьшить величину остаточной неопределенности, избежать

которой полностью практически не удается. (Тут экономисты

заблуждаются, ибо подобное правило не является общим. Чтобы убедиться в

этом достаточно представить себе, например, к каким разрушительным

для экономических теорий последствиям приведут структурные

изменения в мотивах поведения людей. Тогда экономистам придется

переучиваться заново.)

Процесс накопления знаний в экономике протекает во многом так

же, как и в других научных дисциплинах, с той лишь разницей, что

большая роль принадлежит при этом повседневному опыту. Наши

взгляды на какую-либо экономическую теорию или явление

хозяйственной практики всегда содержат долю неопределенности, и нам

приходится их постоянно пересматривать в свете той новой информации,

которая оказалась для нас доступной. Можно надеяться, что итогом

подобной «ревизии» станет приближение знаний о конкретном явлении

12

к «истине». В конечном счете мы хотели бы уметь объяснять и

предсказывать экономическое поведение (агрегированное?) с полной

определенностью, правда, в каждый конкретный момент подобный идеал

воспринимается как весьма отдаленный.

Процесс накопления экономических знаний содержит две ключевые

составляющие: описание представлений о некоторой конкретной теории

или конкретном явлении, накопленных к определенному моменту

времени, и ревизия этих представлений в свете новой информации о

данной теории или данном явлении. По существу, наша книга и посвящена

обсуждению этих двух составляющих.

При описании сформировавшихся представлений о некоторой

теории или о некотором явлении естественно воспользоваться

вероятностными утверждениями. Например, кто-то, опираясь на доступную

информацию и на положения различных экономических теорий, может

сказать, что монетаристское объяснение инфляции более

правдоподобно, чем ее объяснение растущим давлением со стороны затрат. Или

может быть высказано мнение, что неправдоподобно ожидать от

простейшей модели акселератора адекватного объяснения поведения

инвесторов. Еще пример подобного утверждения: имеется менее 1 шанса из 4,

что гипотеза о постоянном доходе позволяет корректно объяснить

агрегированное потребление. Могут существовать и более точные

высказывания: доступные нам данные свидетельствуют о том, что почти

наверняка предельная (маргинальная) агрегированная склонность к

потреблению лежит между 0,5 и 0,7; имеются относительно небольшие шансы

(скажем, меньшие 20 %), что эластичность спроса на деньги по

изменению ставки банковского процента превосходит по величине 1; имеются

очень высокие шансы (скажем, более 95%), что кривая предложения

рабочей силы в индустриально развитых странах обнаруживает

тенденцию к смещению вниз. Таким образом, вероятности принадлежит здесь

ключевая роль.

Открывает книгу вводная глава. За ней следуют две главы,

посвященные основным понятиям теории вероятностей и содержащие факты

этой тебрии, нужные нам в дальнейшем; в этих главах показано,

как неопределенные представления о теориях, явлениях или

переменных величинах можно формализовать, выразив в вероятностных

терминах и воспользовавшись закономерностями, которым подчиняется

случайность. В гл. 2 обсуждаются основные идеи теории вероятностей

для случая простых событий и одной переменной. Большая часть этой

главы посвящена характеристике и обобщению вероятностных

представлений об одной переменной, поскольку содержащиеся в

последующих главах факты излагаются применительно к переменным, а не

событиям. Приводятся три основные вероятностные закона, лежащие в

основе всего последующего материала книги. Один из них может быть

записан в форме теоремы Байеса, которая в свою очередь позволяет нам

корректно построить формальные процедуры пересмотра или

обновления имеющихся представлений в свете поступившей новой информа-

13

ции. Идеи гл. 2 развиваются и обобщаются в гл. 3, где, в частности,

рассмотрены распределения нескольких переменных, строятся их

обобщающие характеристики.

Если способам описания имеющихся представлений посвящены

только две главы, то процедурам их ревизии, пересмотра с учетом

новой информации — остальная часть книги. Гл. 4 начинается с

относительно простых примеров, при формализации которых затем

применяется теорема Байеса (впервые она упоминается в гл. 2).

Заканчивается эта глава дополнительными примерами, и два из них подробно

анализируются затем в гл. 5 и 6.

Понятия, лежащие в основе байесовского подхода, и процедуры,

обеспечивающие его реализацию, описаны в гл. 2, 3 и 4. В остальных

главах книги эти идеи и методы рассматриваются применительно к

различным ситуациям и к решению конкретных задач. Решая

последовательно одну техническую проблему за другой, мы продвигаемся к

приложениям, все более «реалистическим» по своему характеру и

потому теснее связанным с интересами и потребностями экономистов.

Гл. 7, 8 и 9 с этой точки зрения особенно важны, ибо в них идет речь об

эмпирическом исследовании одного или нескольких экономических

соотношений. Однако, как видно из этих глав, более «реалистическая»

постановка прикладных задач сопряжена с увеличением

алгебраической и технической (но не концептуальной) сложности анализа. Вот

почему пришлось включить в книгу гл. 5 и б, материал которых, хотя

и не связан непосредственно с экономикой, содержит сравнительно

простые иллюстрации применения методов анализа из гл. 2, 3 и 4. Гл. 5 и 6

должны помочь читателю обрести уверенность в применении

соответствующих методов и технических средств, в развитии интуитивного

понимания основных теоретических положений, что позволяет

значительно упростить изложение материала в гл. 7, 8 и 9, опуская

алгебраические преобразования и доказательства (частично они перенесены

в приложения). Таким образом, важно не столько умение доказать

результат, сколько обрести навыки, связанные с его применением.

Гл. 5 посвящена одному из наиболее простых приложений

байесовского подхода — задаче определения и последующего уточнения

неизвестной величины, характеризующей долю элементов совокупности,

обладающих некоторым фиксированным свойством. В этой главе

показано, как имеющиеся представления о значении такой доли

пересматриваются с поступлением новой информации. Обсуждается также

вопрос о том, какой смысл следует вкладывать в утверждение об

отсутствии априорной информации о значениях интересующей нас величины.

В гл. 6 рассматриваются несколько более сложные приложения:

задача определения и последующего уточнения значений неизвестной

средней и/или неизвестной дисперсии. Подобные приложения есть часть

пути (своего рода мост) между простой прикладной задачей из гл. 5

и значительно более сложными (но и более полезными для практика)

прикладными задачами из последующих глав.

14

Как уже отмечалось, последние три главы книги содержат наиболее

интересные для экономистов приложения — эмпирические

исследования экономических соотношений. Основные идеи вводятся в гл. 7,

посвященной простейшему из таких соотношений, которое состоит из

единственного уравнения, линейно связывающего две переменные

величины, причем так, что ему соответствуют нормально распределенные

остатки. Показано, как воспользоваться эмпирическими данными о

значениях, входящих в соотношение между переменными, чтобы

сделать выводы о (экономических) параметрах этого соотношения.

Полученную таким образом информацию можно использовать по-разному.

Например, для формулировки вероятностных утверждений об

экономических параметрах или для предсказания будущих значений

экономических переменных.

В гл. 8 методы гл. 7 распространяются на более сложные виды

соотношений, среди которых и случай многих переменных, и нелинейные

связи между переменными. Однако рассматриваются только модели,

состоящие из одного уравнения. Обсуждаются различные

профессиональные приемы, применяемые в эконометрии (область статистикиг

изучающая экономические соотношения) в типичных ситуациях,

возникающих при анализе эмпирических данных.

В гл. 9 дан краткий обзор результатов, поученных для моделей,

состоящих из одновременных уравнений.

В конце книги приведены приложения: перечень важнейших

понятий и необходимый общематематический инструментарий, краткие

доказательства ряда утверждений из гл. 7 и 8, опущенные в основном

тексте, описания компьютерных программ, предназначенных для

реализации байесовских процедур, а также необходимые таблицы

статистических распределений. Наконец, приводится небольшой перечень

книг, рекомендуемых тем, кто захочет расширить свои знания о

предмете. Я надеясь, что у многих такое желание появится.

Каждая глава содержит примеры и заканчивается упражнениями.

Завершая изучение очередной главы, читателю следует выполнить

все упражнения. Это не только позволит закрепить ее содержание, но

дополнит его, поскольку некоторые опущенные по ходу изложения

детали перенесены в упражнения. Вместе с тем некоторые упражнения

в идейном плане повторяют одно другое, поэтому если вы недостаточно

подготовлены, чтобы самостоятельно проводить сложные выкладки, то

опустите упражнения (или отдельные задания), отмеченные

звездочкой; все остальные упражнения не потребуют трудоемких формальных

преобразований.

Отметим еще раз, что книга посвящена байесовскому подходу в ста-,

тистике, который принципиально отличается от классического подхода

(ср., например, с [3]). Именно потому, что в основу данного курса

положена байесовская трактовка вероятности, можно надеяться, что

материал будет восприниматься легче, а содержание окажется

интуитивно более доступным, чем при его «классическом изложении». Тем не ме-

15

нее, поскольку до настоящего времени преобладает классический

подход, в гл. 5, 6 и 7 приводятся сопоставления содержащихся в них

результатов с соответствующими классическими аналогами. Это

необходимо для того, чтобы читатель мог адекватно воспринимать результаты

статистического анализа, выполненного в классической манере, и

представлять собственные выцоды (полученные, конечно, в рамках

байесовского подхода) в виде, доступном для большинства потребителей

статистической информации. Из дальнейшего изложения ясно, что

классический подход можно интерпретировать как частный случай

байесовского подхода; это еще одно преимущество байесовского подхода,

который к тому же оказывается существенно более общим по сравнению с

классическим. Поэтому читателю не следует опасаться, что он

окажется в менее выгодном положении по сравнению с теми, кто изучает

статистику по классическому курсу. Наоборот, к концу обучения он

должен знать больше, понимать это лучше и сверх того, я надеюсь,

получить большее удовлетворение от самого процесса овладения

значениями.

ГЛАВА

2

ОСНОВНЫЕ ПОНЯТИЯ

ТЕОРИИ ВЕРОЯТНОСТЕЙ

2.1. ВВЕДЕНИЕ

Понятие вероятности играет ключевую роль в статистике.

Статистические утверждения об экономических параметрах и экономических

гипотезах формулируются в вероятностных терминах. Например,

анализ данных о доходе и потреблении проливает свет на значение

предельной склонности к потреблению и позволяет сделать вывод в следующей

форме: «имеющиеся наблюдения свидетельствуют, что с вероятностью

0,95 значение предельной склонности к потреблению лежит между

0,59 и 0,63»; «вероятность того, что значение предельной склонности к

потреблению находится между 0 и 1, равна 0,9995, что вполне

соответствует требованиям теории».

В этой главе вводятся основные идеи и понятия теории

вероятностей, а начинается она с краткого обсуждения самого понятия

вероятность. В разделах 2.2 и 2.3 рассматриваются различные способы

описания и обобщения вероятностных утверждений.

В разделе 2.4 приводится описание нескольких специально

отобранных распределений. В разделе 2.5 показано, как основные законы,

которым подчиняются вероятности, позволяют выводить следствия из

некоторых исходных вероятностных утверждений. Раздел 2.6

содержит краткое резюме настоящей главы, а раздел 2.7 — упражнения

к ней.

Центральной для данной книги является идея субъективной

вероятности, состоящая втом, что вероятностные утверждения трактуют

как субъективные ожидания. Так, например, я могу выразить свою

точку зрения на исход предстоящих парламентских выборов, сказав:

«Я полагаю, что имеется 50 шансов «за» и 50 шансов «против» того, что

консервативная партия сформирует очередное правительство».

Аналогично вы можете выразить свой взгляд на возможный исход

следующего мирового чемпионата по футболу, сказав: «Я думаю, английская

команда имеет 1 шанс из 10 стать победительницей». То обстоятельство,

что эти вероятности субъективны, конечно, не должно препятствовать

согласию между отдельными индивидами по поводу какого-либо

конкретного обстоятельства или явления. Например, мы оба можем согла-

17

ситься с тем, что «при подбрасывании монеты имеется 50 шансов из

ста появления герба». Вообще можно ожидать, что формируемые

людьми вероятностные оценки зависят как от количества имеющейся в их

распоряжении информации, так и от способа (или процесса) ее

использования. Таким образом, можно ожидать большего согласия между

людьми, обладающими большей долей общей для них информации.

Пусть теперь ряд индивидов, каждый из которых является

«рациональным человеком» (этот термин мы разъясним позже), сталкивается с

одним и тем же большим количеством информации. Тогда их оценки

после получения этой информации будут обнаруживать тенденцию к

сближению независимо от того, какими были субъективные априорные

ожидания каждого из них.

Индивидуальные вероятностные оценки некоторой неопределенной

переменной или события зависят от аккумулированной индивидом

информации об этой переменной или об этом событии. Правомерно

ожидать изменения таких оценок по мере получения новой информации.

Мы отложим до гл. 4 обсуждение того, как эта новая информация

объединяется с априорными вероятностными оценками; там же будет

рассмотрено понятие начальной, или «априорной», вероятностной оценки.

В этой главе мы займемся гораздо более простой задачей и выясним,

как некоторая данная вероятностная оценка, существующая в

фиксированный момент времени, может быть описана и обобщена.

Укажем на важное различие между понятиями «переменные» и

«события». Занятия economics*, как правило, предопределяют

интерес к переменным, которые предполагаются квантифицированными;

в частности, это могут быть доходы, цены, инвестиции. Однако в ряде

случаев, в особенности, когда того требует более ясное описание

ситуации, приходится обращаться к событиям. Например, «монета выпала

гербом», «англичане победили на мировом чемпионате по футболу»,

«консервативная партия формирует очередное правительство». (На

практике различие становится менее явным, если удается «квантифи-

цировать» множество событий или описать переменную в терминах

событий.) Разделы 2.2—2.4 посвящены рассмотрению переменных, а

раздел 2.5 — событий, кроме того, в разделах 2.2—2.4 мы ограничимся

простейшим случаем одной переменной, т. е. ситуацией, в которой

нас интересует лишь одна переменная величина, изменяющаяся во

времени.

Общий случай многих переменных будет проанализирован в гл. 3.

* Термин economics объединяет определенный круг экономических теорий,

в которых выводы об экономической реальности делают на основе изучения

формальных соотношений между различными количественными

характеристиками. — Примеч. пер.

18

2.2. РАСПРЕДЕЛЕНИЕ,

ФУНКЦИЯ РАСПРЕДЕЛЕНИЯ ВЕРОЯТНОСТЕЙ

И ФУНКЦИЯ ПЛОТНОСТИ

РАСПРЕДЕЛЕНИЯ ВЕРОЯТНОСТЕЙ

Предположим, что перед нами стоит задача описания и обобщения

некоторой вероятностной оценки, соответствующей одной случайной

переменной. Обозначим эту переменную X. Договоримся теперь о

важных для дальнейшего изложения обозначениях и будем пользоваться

прописными буквами для обозначения самой переменной величины,

а соответствующими строчными буквами для обозначения

принимаемых ею значений. Например, если нас интересует предельная

склонность к сбережению, то эту переменную величину можно обозначить

через Ху а х будет одно из ее конкретных значений, скажем 0,59 или

0,63. Если же речь идет о личном недельном доходе (в фунтах

стерлингов), то через X можно обозначить этот доход, а х будет

использоваться для обозначения конкретного значения дохода, допустим 120

или 150.

Вероятностное утверждение будет сокращенно записываться в виде

Р( ), где в скобках должно заключаться некоторое утверждение

относительно переменной величины. Так, например,

Р( 0,59^ Х< 0,63)= 0,9

есть сокращенная запись того, что «с вероятностью 0,9 значения

переменной X лежат на отрезке с концами 0,59 и 0,63» (здесь это

утверждение рассматривается, конечно, как субъективная оценка того, кто его

сформулировал). Аналогично запись

ЯA20< X) ss 0,5

можно расшифровать следующим образом: «имеется 50 шансов из 100,

что значения переменной X не меньше 120». В более общем случае

выражение

Р (хх <; X < х2) в а

означает, что «с вероятностью а значения переменной X лежат между

хх и jc2». Конечно, параметр а, в силу его смысла, заключен между 0 и 1,

т. е. 0< а< 1.

Введем теперь понятие функции распределения вероятностей,

с помощью которого можно реализовать один из способов описания

индивидуальных вероятностных оценок относительно некоторой

переменной X. Функция распределения вероятностей переменной X (или

просто функция распределения переменной X) обозначается /**(•) и

определяется тождеством

Fx (х) - Р (X < х). B.1)

Таким образом, Fx (x) выражает вероятность того, что значение

переменной X не превосходит х. Обычно, когда не возникает неясности,

индекс X опускают и вместо Fx (•) пользуются упрощенной записью

F (•). Функция FK (•) определена для всех значений х между — с» и

19

+ оо; она принимает значения от 0 до 1 включительно. Более того,

следующие свойства функции Fx (•) имеют место независимо от того,

о какой переменной X идет речь:

б) F* ( + «>) = 1,

в) Fx (x)— неубывающая функция х.

<2-2)

(Мы довольствуемся замечанием о том, что следующие утверждения

не вызывают возражений: а) вероятность того, что переменная X

принимает значение, не превосходящее — оо, равна нулю; б) вероятность

того, что переменная X принимает значение, не превосходящее + оо,

равна единице; в) когда значение х увеличилось, вероятность того, что

переменная X не превосходит значения х> не может уменьшиться.)

Все эти свойства сразу же вытекают из того, что Fx (x) служит мерой

вероятности, «накопленной» на всем интервале от — оо до х

включительно, т. е. кумулятивной вероятности.

Приведем три простых примера, иллюстрирующих понятие функции

распределения вероятностей.

В первом примере переменная X — число, изображенное на

выпавшей грани игральной кости. Возможные значения х — числа 1, 2, 3, 4,

5 и 6. Вообще говоря, вероятностные оценки относительно каждого из

этих значений переменной X могут варьироваться от индивида к

индивиду. Предположим, однако, что мы имеем дело со случаем, когда

некто долгое время наблюдал бросание этой кости и пришел к выводу,

что все ее шесть граней совершенно одинаковы. Эту индивидуальную

оценку можно выразить так:

р^.^М/б. при* = 1,2,3,4,5,6; B.3)

| 0, при остальных х.

Определим теперь Fx (x) для всех возможных значений х. Очевидно,

что Fx (x) ^Одля всех x<Z 1, поскольку переменная X не может

принять значение, меньшее 1. К тому же Fx A) ---- 1/6, ибо вероятность

того, что переменная X примет значение, не превосходящее 1, в точности

совпадает с вероятностью того, что эта переменная будет равна 1;

Fx (х) -~ -g- для ху удовлетворяющих ограничениям 1 ^ х <С 2, так

как между 1 и 2, если не включать концы этого промежутка, нет ни

одного значения, которое может принять переменная X. (Например,

Fx(l,8) Р(Х < 1,8) -Р{Х 1)- 1). Далее, Fx B) = |.

Это вытекает из того, что вероятность для переменной X оказаться

меньшей или равной 2 в точности равна вероятности для этой перемен-

9

ной принять одно из двух значений: 1 или 2, т. е. равна ~. Для всех

2

ху удовлетворяющих ограничениям 2 ^ х < 3, также Fx (x) ¦=- -~->

20

1.

ибо между 2 и 3 (исключая концы интервала) нет чисел, которые могут

стать значениями переменной X. Продолжая рассуждать таким

образом, мы получим следующее (несколько громоздкое, но исключающее

любые недоразумения) выражение для Fx(-)'

О,

1/6,

2/6,

3/6,

4/6,

5/6,

1

2

3

4

5

х

х ¦

х

: X ¦

'. х ¦

2,

3,

4,

5,

6,

B.4)

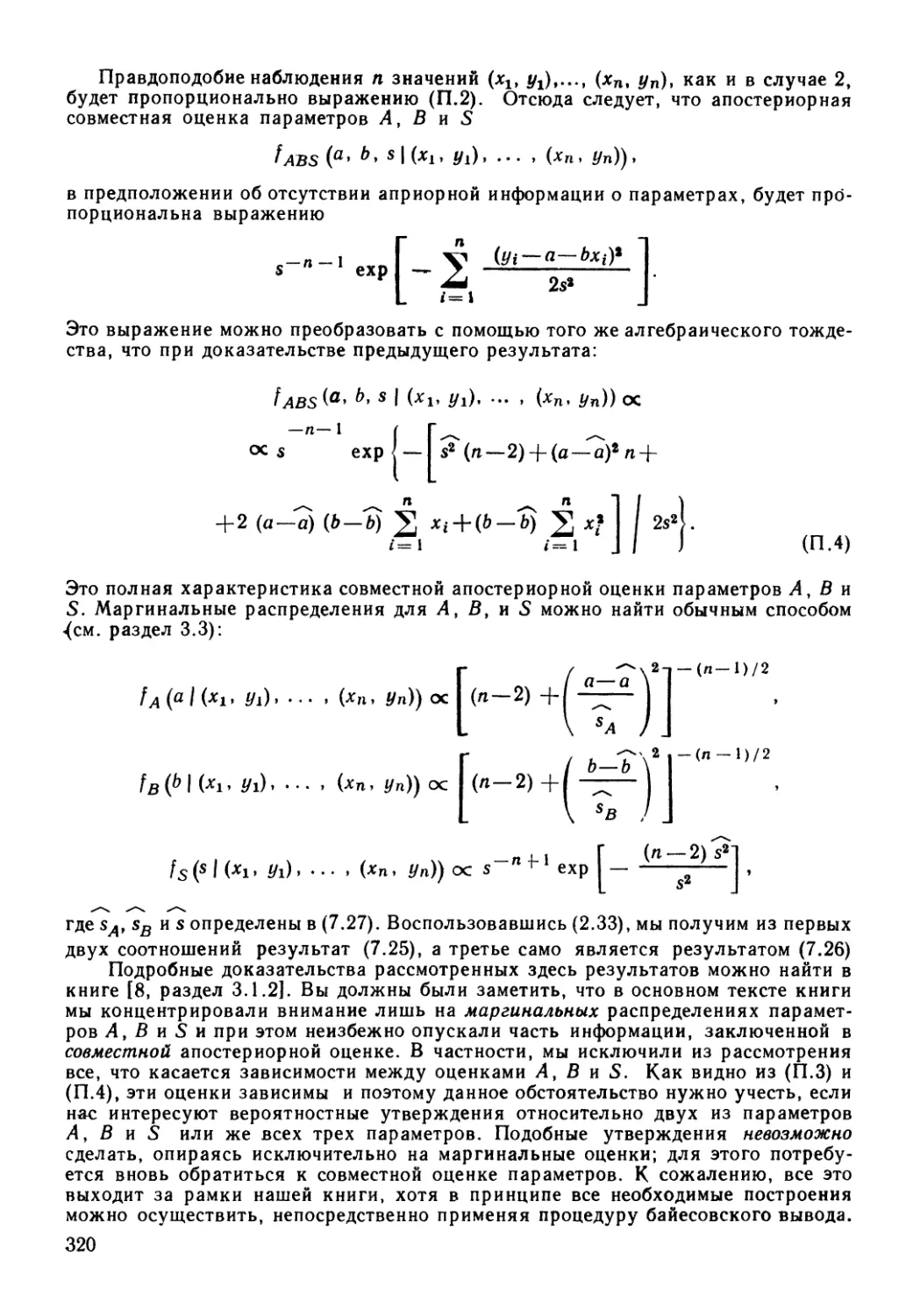

Изображенный на рис 2.1 график проясняет ситуацию. (Правда,

пурист заметит, что при построении графика была, видимо, допущена

небрежность, состоящая в соединении вертикальными отрезками

последовательных горизонтальных ступеней, из-за чего так и не удается

установить точное значение функции для соответствующих целых точек оси

абсцисс.)

1 -

Рис. 2.1. Функция распределения для чисел, выпадающих при бросании кости

Построенный нами график функции распределения напоминает

лестницу. Функцию, которой он соответствует, называют ступенчатой

функцией. Вертикальные отрезки графика в точности отвечают целым

числам 1, 2, 3, 4, 5 и 6 — значениям переменной X; в то же время всем

остальным точкам оси абсцисс не отвечают значения переменной Ху и

над ними располагаются горизонтальные отрезки графика. Кроме

того, высота «скачка» в каждой из первых шести натуральных точек

равна -^—вероятности, с которой переменная X принимает соответст-

21

вующее значение. Это очень важное общее свойство и к нему мы

неоднократно будем обращаться в этой главе.

Рассмотрим теперь второй пример, в котором переменная величина

X имеет совершенно иную природу. Представим себе горизонтально

расположенный диск, в центре его укреплена короткая вертикальная ось

и на ней свободно вращается стрелка. Предположим, что диск по

окружности равномерно и непрерывно калиброван от 0 до 1 (рис. 2.2, а).

Определим теперь переменную X как принимающую значения, на

которые указывает стрелка в момент ее останова после вращения. Как

и прежде, вероятностные оценки по поводу ожидаемого значения пере-

0,75

0,25

Рис. 2.2. Эксперимент со стрелкой:

а) замечание: окружность непрерывно калибрована от 0 до 1,

б) функция распределения вероятностей переменной .V

менной X могут изменяться от индивида к индивиду (в зависимости от

аккумулированной каждым из них информации об эксперименте), но

мы вновь будем рассматривать оценки индивида, считающего стрелку

несмещенной и потому с одинаковым успехом ожидающего ее останова

в любом возможном положении. В этом случае легко вывести вид

функции распределения вероятностей. Так, Fx @,5) -= 0,5, поскольку

имеется 1 шанс из 2, что стрелка остановится в правом полукруге;

аналогично Fx @,25) =• 0,25, ибо есть лишь 1 шанс из 4, что стрелка

остановится в первой четверти; аналогично/^ @,75) = 0,75. Здесь

обнаруживается закономерность, которую можно описать следующим образом:

Fx

при 0

1.

{Если такое описание представляется вам недостаточно обоснованным,

рассмотрите еще несколько примеров.) Завершая описание Fx (•)»

заметим, что X не принимает значений, меньших 0, т. е. Fx (х)=* 0 при

х < 0, и X не может стать больше 1, т. е. Fx (х) — 1 для х > 1.

(Последнее справедиво, так как для любого х > 1 значения X всегда бу-

22

дут меньше х). Объединяя все выводы относительно Fx (x), мы можем

записать

О, х < О,

Fx(x) =

х,

(рис. 2.2, б).

Сравнивая функции распределения из двух рассмотренных

примеров, мы обнаружим одно их существенное сходство: графики обеих

функций имеют горизонтальные линии. Эти линии указывают на

значения х, которые переменная X не принимает (в первом случае это все

числа, кроме целых от 1 до 6, во втором— все числа вне отрезка [0;1]).

Мы можем также отметить и существенное различие между этими

двумя функциями: горизонтальные линии графика первой функции

соединяются вертикальными отрезками, т. е. функция совершает в каждой

из шести точек скачок, а горизонтальные части графика второй функции

соединяются отрезком наклонной прямой, что свидетельствует о

непрерывном возрастании функции распределения. Отмеченное различие

отражает неодинаковую природу исходных переменных величин: в первом

примере переменная X дискретная, а во втором - - непрерывная. (Во

втором примере переменная X принимает все значения от 0 до 1, как бы

пробегая их непрерывно, в то время как в первом примере значениями

X являются только некоторые дискретные точки. Если у вас остались

неясности по поводу различий между дискретными и непрерывными

переменными, вам придется обратиться к курсу математики,

содержащему более подробное изложение соответствующих проблем.) Как мы

видели, трактовка основных понятий в дискретном и непрерывном

случаях различна.

Заметим, что в каждом из двух рассмотренных примеров

существует некоторое множество возможных значений переменной X и имеет

место неопределенность относительно того, какое конкретное значение

переменной можно будет наблюдать в данном частном случае (в

результате бросания кости или вращения стрелки). В нашей книге речь идет

главным образом о проблемах, постановка которых непременно

связана с существованием неопределенности. Когда неопределенность

отсутствует, то язык теории вероятностей не нужен. Вместе с тем определен-

ность, или детерминированность, есть специальный случай

неопределенности, и потому соответствующие методы могут быть

применены и в этом вырожденном случае.

Рассмотрим переменную X, определенную как мой возраст на

26 сентября 1984 г. При отсутствии какой-либо информации обо мне

ваша оценка X окажется неопределенной. (Как будет выглядеть ваша

функция распределения?) Если же я скажу вам, что родился во время

второй мировой войны, то это значительно сузит рамки

неопределенности. (Какой станет ваша функция распределения теперь?) Если же я

сообщу вам, что родился 26 сентября 1944 г., то всякая неопределен-

23

ность исчезнет: мы окажемся перед фактом, что X = 40. Ваша функция

распределения (в данном случае у каждого она окажется одной и той

же) будет иметь вид, как на рис. 2.3, а, с единственным скачком от 0

до 1 в точке х = 40.

Когда я прошу кого-то из своих студентов оценить мой возраст

(значение переменной X в данном примере), типичный ответ до того, как

я поделюсь с ними какой-либо информацией, таков: «Думаю, вы

старше 36 лет, но вам не больше 42; в этом промежутке все значения

кажутся мне одинаково возможными». Этой оценке соответствует функция

распределения, изображенная на рис. 2.3, б.

40

36

42

а.)

Рис. 2.3. Две функции распределения возраста автора:

а) вырожденная (неопределенность отсутствует);

б) невырожденная (неопределенность имеет место)

Функция распределения дает нам один из возможных способов

представления вероятностных оценок значений некоторой переменной.

Эта функция удобна тем, что ею можно пользоваться как в случае

дискретных, так и в случае непрерывных переменных. Существует,

однако, иное представление вероятностных оценок, интуитивно более

оправданное и геометрически лучше интерпретируемое. Некоторое

неудобство, правда, связано с тем, что формы этого представления

различны для дискретного и непрерывного случаев. Начнем с первой,

дискретной, формы.

Как уже отмечалось, отличительным свойством функции

распределения дискретной переменной является наличие последовательности

горизонтальных линий на ее графике, соединенных между собой

вертикальными отрезками (скачками, ступенями) Эти скачки

соответствуют тем дискретным значениям, которые переменная принимает, а

величина скачка в каждой точке равна вероятности, с какой переменная

принимает соответствующее значение. Это было ясно еще из рис. 2.1.

Чтобы описать скачок формально, предположим, что он происходит в

точке X = х\ в основании ступени значение функции распределения

равно Р (X < х), а на вершине ступени оно равно Р (X ^ х)\ раз-

24

ность между этими значениями есть Р (X ^ х) — Р (X < х)> т. е.

р(Х = х). Теперь мы можем определить новую функцию,

обозначаемую fx (•), следующим образом:

(О для всех точек, где график Fx (x)

fx кх) — \

[ величине скачка, если имеет место скачо

Следовательно,

fx(x) = P(X = x) для всех х, B.7)

что объясняет, почему fx (•) называют функцией вероятностей

переменной X. Для первого из наших примеров график функции

вероятностей переменной X изображен на рис. 2.4, а. Еще один пример до-

горизонтален,

B.6)

'хМ

/х(х)

•Л'-

0 1 2 3 4 5 6 х

г

б)

1 2

8)

Рис. 2.4. Введение функции вероятностей:

а) X — число на выпавшей грани игральной кости;

б) — в) X — число выпадений герба при двукратном бросании монеты

ставляет нам функция вероятностей переменной X, определенная как

число благоприятных исходов при двух бросаниях «правильной»

монеты (рис. 2.4, б). На рис. 2.4, в изображена соответствующая функция

распределения. Следует отметить, что функция вероятностей равна

нулю всюду, за исключением тех дискретных значений, которые может

принимать переменная (целые числа от 1 до 6 — в первом примере,

числа 0,1, 2 — во втором).

Если мы попытаемся распространить данное только что

определение на случай непрерывной переменной, то столкнемся с серьезными

трудностями. Начнем хотя бы с отсутствия скачков у функции

распределения непрерывной переменной (см. рис. 2. 2, б и 2.3,6), в силу чего

определение B.6) применить непросто. Следует ли стремиться к

сохранению свойства B.7)? Обратимся к нашему второму примеру (см.

рис. 2.2). Что такое, например, Р (X = 0,1)? Нуль\ (В самом деле,

^@,1<Х< 0,9) = 0,8; Р@,1 < X ^ 0,5) - 0,4; вообще,

Р @,1 < X ^ 0,1 + а) = а. Таким образом, положив а = 0, мы

получим Р @,1 < Х< 0,1) - 0, т. е. Р (X = 0,1) - 0).

Повторим те же рассуждения и покажем, что Р (X = х) = 0

для всех х\ (Это вытекает из общего результата, в силу которого

25

Р (х ^ X <; х + а) = а.) Итак, если мы определим функцию

вероятностей по аналогии с B.7), то придется согласиться с тем, что она

равна нулю при всех х (т. е. у функции распределения нет скачков).

Подобная функция вероятностей вряд ли окажется полезной и ничего

не сообщит нам о вероятностных оценках во втором примере.

Проблема в том, что во втором примере переменная X является

непрерывной. Когда х пробегает значения от 0 до 1, вероятности

накапливаются непрерывно; таких крупных «вкладов» в общую сумму, как

могла внести точка в случае дискретной переменной, здесь не будет.

В непрерывном случае нельзя, указав точку х> спросить, какова

вероятность того, что именно она окажется интересующим нас частным

значением. Оправданным будет вопрос о скорости аккумуляции

вероятностей для каждого значения х. (Здесь может быть полезна аналогия: в

какой бы точке ни находился движущийся автомобиль, неправомерно

спрашивать, как далеко он уехал в данный момент; правильнее задать

вопрос о скорости, с которой автомобиль в данный момент движется.)

Скорость, с которой аккумулируется вероятность, задает тангенс угла

наклона графика функции распределения к оси абсцисс: чем круче его

наклон, тем быстрее идет накопление вероятностей в функции

распределения. Теперь мы можем определить новую функцию, которую будем

обозначать fx (•)•'

fx (x) = Fx (x) se dFx (x)/dx B.8)

(=s= тангенсу угла наклона касательной Fx (х) к оси я). Чтобы мы

могли пользоваться этими функциями, нам необходимы некоторые

элементарные сведения операционального характера. Читатель, не

обладающий этими знаниями, может обратиться к приложению или принять

соответствующие результаты на веру (по сути, они не столь

существенны для понимания дальнейшего). Тот, кто свободно владеет

этим аппаратом, легко воспримет следующее определение:

h (х) - lim Г Р(Х<х+*х)-Р(Х<х) 11 B 9)

которое является следствием B.8) и B.1). Числитель выражения в

квадратных скобках есть вероятность того, что X лежит в интервале [х, х +

+ Дл:], а знаменатель — длина этого интервала — есть плотность

распределения вероятностей на интервале [х> х+Ах]. Таким образом,

fx (х) — мера плотности вероятностей в точке х. Функцию fx (•)

называют функцией плотности вероятностей переменной X или просто

функцией плотности вероятностей. (Мы будем пользоваться одной и

той же буквой для обозначения функции вероятностей в дискретном

случае и функции плотности вероятностей в непрерывном случае, не

опасаясь недоразумений, поскольку из контекста всегда ясно, о чем

идет речь.)

Чтобы получить функцию плотности вероятностей непрерывной

переменной из функции распределения вероятностей, нужно последнюю

просто продифференцировать (см. B.8)). Так, функция плотности

26

вероятностей для второго из рассмотренных выше примеров

(эксперимент со стрелкой, см. рис. 2.2) задается (в силу B.5)) соотношением

0, для остальных х

(рис. 2.5, а). Как мы видим, функция плотности вероятностей

принимает одно и то же значение в каждой точке отрезка [0,1]; так как

одинаково правдоподобен останов стрелки в любой точке данного интервала.

0,5 0,75 1

<L) б)

Рис. 2.5. Функция плотности вероятностей для

эксперимента со стрелкой. (Площадь заштрихованная на рис. 2.5,6

равна 0,25=Р @,5<Х<0,75).)

Поскольку действия дифференцирования и интегрирования взаимно

обратны, г fx (-) является производной от Fx (•)> т0 функция Fx (•)

в свою очередь должна получаться из /*(•) интегрированием. Если

быть абсолютно точным, то можно записать:

fx(t)dt.

B.11)

t= — оо

Геометрически такая запись попросту означает, что Fx (x) — площадь

под той частью кривой fx (•)> которая расположена левее х. Из B.11)

немедленно вытекает, что

Fx(x2)-Fx(xt) = f fx(t)dt.

B.12)

Левая часть B.12) есть не что иное, как разность Р (X < х2) —

— Р (X < хх)у т. е. Р (*! < X < х2); таким образом, B.12) можно

записать в виде

L

= [ fx(t)dt.

B.13)

27

Геометрический смысл этого выражения весьма прост: вероятность

того, что переменная X лежит между хг и х2, задается площадью

трапеции, которая образуется под частью кривой функции плотности

вероятностей, ограниченной значениями хх и х2. Итак (и это очень важное

свойство), площади под кривой функции плотности вероятностей сами

являются вероятностями. Отсюда сразу же следует, что общая

площадь между графиком функции плотности вероятностей и осью ОХ

равна единице^ поскольку во всех случаях общая вероятность равна

единице.

Чтобы проиллюстрировать этот важный результат, вновь

обратимся к рис. 2.5, где изображена функция плотности вероятностей

переменной X из эксперимента со стрелкой. Очевидно, что общая площадь под

кривой fx(-) равна 1. Более того, площади сами являются

вероятностями, что видно на примере рис. 2.5, б: заштрихованная площадь равна

0,25 (прямоугольник высотой 1 и шириной 0,25) и этому же равна

вероятность того, что переменная X лежит между 0,5 и 0,75 (другими

словами, что стрелка остановится в юго-западном секторе круга).

Убедиться в том же, рассматривая другие площади, вы сможете

самостоятельно.

Возвращаясь к общему случаю, заметим, что для непрерывной

переменной различие, скажем, между Р (X ^ х) и Р (X <С х)

несущественно, поскольку Р (X = х), как мы уже видели, равна нулю. Если

же такого объяснения вам недостаточно, то обдумайте следующий

эвристический аргумент: «Поскольку между 0 и 1 имеется бесконечно

много равновероятных значений переменной X, то вероятность того,

что эта переменная в точности равна одному из них, будет 1/оо, т. е.

нуль».

Как уже отмечалось, недостаток знаний о вычислительных

процедурах не помешает пониманию материала, содержащегося в данном

разделе; что действительно необходимо знать, так это связь между

функцией плотности вероятностей /х(-) и функцией распределения

Fx(-)> первая из которых характеризует тангенс угла наклона (к оси

абсцисс) касательной, проведенной к графику второй в точке х, а вторая

— площадь части плоскости между графиком первой и осью абсцисс

до вертикальной прямой, соответствующей значению х. Пояснить эту

взаимосвязь можно с помощью аналогии между предельными и

совокупными затратами или предельным и совокупным доходом. (Кривая

предельных затрат также характеризует «наклон» кривой 'общих

затрат, в то время как вторая характеризует площадь части плоскости

между первой кривой и осью абсцисс.) Если угодно, можно

представлять себе Fx (x) как суммарную (общую) вероятность появления

значений вплоть до х, a fx (x) — как предельную (маргинальную)

вероятность значения х.

Последний из рассмотренных в этом разделе примеров посвящен

случаю непрерывной переменной. Обратимся вновь к эксперименту со

стрелкой (см. рис. 2.2, а), но предположим теперь, что выбрана новая

28

система измерений; северо-восточному сектору окружности

соответствуют значения от 0 до 2, изменяющиеся непрерывно и равномерно,

южной полуокружности — значения от 2 до 3, тоже непрерывно и

равномерно меняющиеся, и, наконец, северо-западному сектору —

значения от 3 до 5 (рис. 2. 6, а). Пусть переменная X определена как

прежде, и мы предположим, что стрелка является «правильной», т. е.

одинаково правдоподобно, что она остановится в любом из возможных

положений. Прежде всего, построим функцию распределения; это

можно осуществить, вычисляя ее значения для специфических значений

переменной, "включая точки на границах и внутри соответствующих про-

Рис. 2.6. Модифицированный эксперимент со стрелкой:

а) описание эксперимента;

б) функция распределения;

в) функция плотности вероятностей

межутков, либо на основе некоторых более общих соображений.

(Можно найти значение функции распределения для специфических

значений аргумента: Fx A) - 0,125; Fx B) = 0,25; Fx B,25) -

= 0,375; Fx B,5) = 0,5; Fx B,75) = 0,625; Fx C) - 0,75;

Fx D) -0,875; Fx E) = 1.)

Зная функцию распределения, нетрудно получить функцию

плотности вероятностей путем дифференцирования. График первой из этих

функций, изображенный на рис. 2.6, б, позволяет установить, что /\х(«)

имеет тангенс угла наклона к оси абсцисс, равный -g- на промежутке

от 0 до 2; равный у на промежутке от 2 до 3; равный -g- на

промежутке от 3 до 5 и равный 0 во всех остальных точках. Таким образом, fx (•)

принимает значение -g- на промежутке от 0 до 2; значение -j на

промежутке от 2 до 3; значение -g- на промежутке от 3 до 5 и значение 0 в

остальных точках (рис. 2.6, в). Из рис. 2.6, в видно, что общая площадь

между графиком функции /х (•) и осью абсцисс равна 1, что

непременно должно иметь место, если функция /*(•) построена правильно.

(Это полезный и достаточно надежный способ проверки, которым сле^

29

дует пользоваться для самоконтроля.) Можно проверить, что площади

трапеций под графиком функции fx (•) совпадают с соответствующими

величинами вероятностей. Например, площадь между графиком

функции fx (•) и осью абсцисс, ограниченная значениями переменной 1 и 2,

равна -g-, т. е. вероятности, что стрелка остановится в одной из точек

этой дуги.

В данном разделе были введены три важные функции, с помощью

которых можно описать вероятностные утверждения в случае одной

переменной. Первая — функция распределения, применимая как для

дискретных, так и для непрерывных переменных и позволяющая измерить

кумулятивную вероятность. Вторая — функция вероятностей; она

предназначена только для описания случая дискретной переменной и

измеряет вероятность появления каждого из ее значений. Третья —

функция плотности распределения вероятностей; она определена лишь

для непрерывной переменной и служит мерой маргинальной

(предельной) вероятности.

2.3. ОБОБЩАЮЩИЕ ХАРАКТЕРИСТИКИ

Из определения функции распределения вероятностей (равным

образом это относится и к функции вероятностей, и к функции плотности

вероятностей) следует, что она содержит всю информацию об

индивидуальной вероятностной оценке в случае одной переменной, т. е.

является полной характеристикой. Эта полнота может в одних ситуациях

оказаться удобной, а в других, когда возникают трудности с

сопоставлением различных элементов, она становится препятствием для

применения таких обобщающих функций. Наконец, не всегда подобная

полнота необходима, поскольку лишь некоторые свойства оценок,

построенных с помощью рассматриваемых функций, могут оказаться

полезными при решении конкретной проблемы. Нас будет в дальнейшем

интересовать случай, когда обобщение ключевых свойств

вероятностной оценки оправдано, и целесообразно использование полученных

функций в качестве полных характеристик. В данном разделе речь идет

о таких обобщающих характеристиках, причем содержание раздела не

всегда жестко связано с последующим изложением.

Обобщающие характеристики, рассматриваемые в данном разделе,

можно разбить на две основные группы: вероятностные интервалы

(наименьшей длины) и более распространенные измерители

центральной тенденции и разброса. Начнем с первой из этих двух групп.

Часто бывает полезным знать промежуток фиксированной длины»

в который (в соответствии с индивидуальной точкой зрения)

переменная попадает с наибольшей вероятностью, или же минимальный

промежуток, в который эта же переменная попадает с фиксированной

вероятностью. В частности, нас будет интересовать информация,

содержащаяся в индивидуальных оценках типа: «переменная X почти навер-

30

няка (это значит, что с вероятностью 0,95) лежит между 120 и 132».

Для достижения указанных целей введем понятие а-процентного

вероятностного интервала: в общем случае это некоторый промежуток

[Хи х2\ ДЛЯ которого Р (х1^.Х ^ х2) = -^-, т. е. имеется а

процентов шансов, что переменная X лежит в этом промежутке. Рассмотрим

эксперимент со стрелкой (см. рис. 2.2, а), а вероятностную оценку,

содержащуюся в функции распределения, возьмем из рис. 2.2, б. Легко

заключить, например, что 80-процентным вероятностным интервалом

будет промежуток [0,1; 0,9]; 90-процентным—промежуток [0,05;

0,95], а 100-процентным вероятностным интервалом окажется проме-

-1 0 1

Рис. 2.7. Треугольная функция плотности вероятностей

жуток [0; 1]. Однако не случайно речь шла о некотором вероятностном

интервале, а не о конкретном, ибо существует много вероятностных

интервалов, соответствующих одному процентному уровню. Чтобы

ограничить число возможных вариантов, можно рассматривать

симметричные вероятностные интервалы, как это было сделано в приведенных

только что примерах. В более общем случае (в нашем примере это уже

не приведет к уменьшению числа возможных интервалов) можно

рассматривать а-процентный вероятностный интервал наименьшей

длины, который формально определяется так:

а-процентный вероятностный интервал наименьшей длины

для переменной X есть промежуток [х19 х2], такой, что

а

Р (хг ^ X ^ х2) = ~, и при этом величина х2 — хх

является наименьшей.из возможных.

Проиллюстрируем это определение на примере функции плотности

вероятностей, график которой изображен на рис. 2.7. Для данного

случая 95-процентный вероятностный интервал наименьшей длины будет

задан промежутком с концами —0,7764 и + 0,7764 (точнее, от

—1 +V0,05 до 1—V0,05). Вы можете проверить этот результат, равно

31

B.14)

как и то, что еще один 95-процентный вероятностный интервал будет

задан конечными точками — 1 и +0,6838 (точнее, от —1 до 1 — УоЛ").

Заметим, что этот второй промежуток имеет большую длину (она равна

1,6838) в сравнении с первым, длина которого (она равна 1,5528)

является наименьшей. Обратим внимание и на то, что в нашем конкретном

примере интервал наименьшей длины симметричен относительно нуля.

Это отражает то обстоятельство, что функция плотности вероятностей

также симметрична относительно нуля. Полученный результат

может быть сформулирован и доказан в более общем виде: любой

вероятностный интервал наименьшей длины для симметричной функции

плотности вероятностей, имеющей единственную «вершину», имеет ту же

ось симметрии. Это утверждение формулируется для непрерывной

переменной следующим образом.

Пусть

Р (*i < X < Х%) = а/100.

Промежуток [хг\ х2] будет а-процентным вероятностным интервалом

наименьшей длины для переменной X тогда и только тогда, когда

fx (#i) = fx (x2). Доказательство мы оставляем читателю в качестве

упражнения.

В дальнейшем будут рассматриваться только вероятностные

интервалы наименьшей длины и поэтому соответствующее уточнение будет

опускаться.

Для непрерывной переменной всегда существует интересующий нас

а-процентный вероятностный интервал. Однако для дискретных

переменных его не всегда можно указать, поскольку неизбежно скопление

значительных «масс» вероятности в дискретных точках. Рассмотрим в

качестве иллюстрации пример с бросанием игральной кости, для

которого функция распределения вероятностей изображена на рис. 2.1,

а функция вероятностей— на рис. 2.4, а. Мы видим, что промежуток [3;

4] является 33 -^-процентным вероятностным интервалом, промежуток

о

[2; 5] — 66 ^--процентным вероятностным интервалом, а [1; 6] — 100-

процентным вероятностным интервалом. Однако невозможно

обнаружить, например, 90-процентный или 80-процентный вероятностные

интервалы. Проблема возникает, конечно, из-за того, что вероятности

сосредоточены в шести точках, по — в каждой. Вместе с тем из-за

этого вряд ли возникнут серьезные трудности при решении

практических задач.

Обратимся теперь ко второй группе обобщающих характеристик,

куда входят более употребительные измерители центральной

тенденции и измерители разброса. Начнем с первых. Идея измерения

центральной тенденции непосредственно отражается в таких понятиях, как

«типичное», «среднее» или «представительное» значение переменной.

Существуют различные способы для выражения этих понятий и все

зависит от того, как их интерпретировать и какой смысл в них вкладывать.

32

Рассмотрим несколько наиболее распространенных способов

измерения. Одной из естественных характеристик служит значение

переменной X, которое является наиболее правдоподобным (в соответствии с

индивидуальными вероятностными оценками). Это значение X, если оно

единственно, называют модальным значением переменной X, или

просто модой X. Формально понятие моды можно определить как для

дискретного, так и для непрерывного случаев следующим образом:

Мл —мода X, если fx (Мх) ^ fx (х) для всех х. B.15)

Итак, для дискретной переменной мода — такое значение

переменной, которому соответствует наибольшая вероятность, а для

непрерывной переменной это значение переменной, которому соответствует

наибольшее значение плотности вероятностей. В двух из рассмотренных в

этой главе примеров мода единственна: на графике, изображенном на

рис. 2.4, б (функция вероятностей числа выпавших гербов при

двукратном бросании монеты), мода равна 1; на графике, изображенном

на рис. 2.7, мода равна 0. В остальных примерах модальное значение

не было единственным: из рис. 2.4, а следует, что все значения

переменной одинаково правдоподобны и потому каждое из них является

модальным; то же самое можно сказать по поводу ситуации,

соответствующей рис. 2.5; на графике, изображенном на рис. 2.6, в, можно

указать отрезок модальных значений [2; 3].

Другой «представительной» характеристикой распределения

служит значение переменной X, находящееся как бы в середине в том

смысле, что большие его значения столь же правдоподобны для X, как и

меньшие. Это значение X, если оно существует и единственно,

называется медианным значением переменной X, или медианой X. Для

непрерывной переменной медиану можно просто определить следующим

образом:

тх — медиана X, если Fx (пгх) =¦ 0,5. B.16)

Итак, Р (X ^ тх) Р (X ^пгх) — 0,5. Другими словами,

имеется 50 на 50 шансов, что значение X окажется больше или меньше

медианы. На графике, изображенном на рис. 2.5, а, медиана равна 0,5;

на графике рис. 2.6, в она равна 2,5; на графике рис. 2.7 она равна 0.

Для дискретных переменных определение B.16) не обязательно ведет

к получению единственного значения тх: например, как видно из

рис. 2.1, уравнению Fx (x) - 0,5 удовлетворяют все значения х такие,

что 3 ^ х ^4. В этом случае можно либо договориться, что все

значения между 3 и 4 являются медианными, либо считать медианой

значение 3,5. В других случаях определение BЛ6) удается применить

непосредственно. Например, в ситуации, соответствующей рис. 2.4,

медиана, очевидно, равна 1.

Третьей характеристикой и последней из тех, которые мы

рассматриваем в качестве «претендентов» на «представительное» отражение

всех значений переменной X, является обычная арифметическая

средняя величина. Для дискретных переменных это просто взвешенная

средняя всех возможных значений переменной X, где весами служат со-

2 Зак. 2161 33

ответствующие вероятности. Формально это определение записывают

так:

ЕХ — арифметическая средняя Х\ EX = Hxfx{x). B.17)

Здесь суммирование осуществляется по всем значениям х (можно

также сказать, что по всем значениям от — с» до + оо или по всем

возможным значениям, поскольку fx (х) обращается в нуль, когда

переменная не принимает соответствующих значений х).

Объясним теперь выбор обозначения ЕХ для арифметической

средней. Воспользуемся двумя иллюстративными примерами. Первый —

бросание игральной кости (см. рис. 2.4, а). Здесь X принимает

значения 1, 2, 3, 4, 5 и 6, причем каждому соответствует вероятность 1/6.

Пользуясь определением B.17), вычислим значение ЕХ:

ЕХ=^\ х 4" + 2х -Г + 3х4- + 4х ~- + 5х —+ 6х — = 3,5.

о и 6 6 6 6

Второй пример — два бросания монеты (см. рис. 2.4, б). Здесь X —

число выпадений герба в двух бросаниях — может принимать значения

О, 1 и 2, которым соответствуют вероятности 1/4, 1/2 и 1/4. С помощью

определения B.17) получим

?Х = 0х—+ 1х—+ 2х —=1.

4 2 4

Этот последний результат можно интерпретировать так: в среднем

число выпадений герба при двух бросаниях монеты равно 1. Такая

интерпретация естественна. Однако на полученное в итоге значение 1

можно взглянуть с иной точки зрения — как на ожидаемое число

выпадений герба в двух бросаниях монеты. Именно в силу этого

рассматриваемая нами средняя величина записывается как EX: E —

начальная буква английского слова Expected, и ЕХ означает ожидаемое

значение X.

Возвращаясь теперь к примеру с бросанием кости, отметим

некоторую «экстравагантность» выражения: «ожидаемое число,

изображенное на выпавшей грани, равно 3,5» — ведь грани с таким числом

не существует! Предположим, однако, что вы принимаете участие в

игре в которой каждый поочередно бросает кость и за каждую единицу

выпавшего числа платит 1 фунт. Тогда вы можете ожидать, что один

круг этой игры обойдется вам (в среднем) в 3,5 фунта.

Выражение B.17) определяет ожидаемое значение для дискретной

переменной; для непрерывной переменной соответствующее

определение имеет вид:

ЕХ — арифметическая средняя Х\ЕХ = J xfx (х) dx. B.18)

Интегрирование здесь ведется по всем значениям х (безразлично, будем

ли мы говорить, что оно ведется по всем значениям от — оо до + оо или

утверждать, что рассматриваются все возможные значения х, так как

итог будет один и тот же, ибо fx (x) обращается в нуль при всех значе-

34

ниях х, которые не относятся к возможным). Выражение B.18)

означает, что ЕХ является взвешенной средней (всех!) различных

значений X, причем роль весов выполняют плотности вероятности для

соответствующих значений х. Читатель, достаточно искушенный в

формальных преобразованиях, легко разглядит в B.18) аналог B.17).

Приведем два иллюстративных примера.

Первый — эксперимент со срелкой. Соответствующая функция

плотности вероятностей приведена в B.10), а ее график — на

рис. 2.5, а. С помощью B.18) мы обнаружим, что

ЕХ=

= J

Таким образом, ожидаемое значение X в эксперименте со стрелкой

равно 1/2, что вполне согласуется с интуитивными представлениями.

Второй пример основан на функции плотности вероятностей, график

которой изображен на рис. 2.7.

"х+1, — l<x<0,

fx(x)= l — Xj 0<jc<1, B.19)

0 при остальных х.

Применяя определение B.18), вычислим значение ЕХ:

+ ОО 0 1

ЕХ - fx/x(x)dx = ^x(x+l)dx+ fx(l— x)dx =

+4-4

'=0.

Итак, ожидаемое значение (вряд ли это окажется неожиданным) равно

нулю!

(Прежде чем продолжить, заверим читателя, не очень искушенного

в математических выкладках, что многие важные результаты можно

получить, опираясь на здравый смысл, а не только путем их формального

вывода. Если же некоторые из них читатель просто примет на веру, то

это не помешает ему понять основные положения статистики.)

Увлечение техническими деталями далеко не всегда оказывается

полезным. В этом легко убедятся те читатели, которые сосредоточат

внимание на поддающихся обобщению свойствах конкретного примера

и благодаря этому получат некоторый весьма важный результат. Если

распределение симметрично, то ожидаемое значение переменной

определяет ось симметрии. Более того, если у симметричного распределения

существуют единственная мода и единственная медиана, то они также

совпадают с точкой, через которую проходит ось симметрии.

(Распределение называют симметричным, если график функции вероятностей

или график функции плотности вероятностей имеет ось симметрии.) Та-

2* 35

ким образом, для симметричного унимодального (т. е. с единственной

модой) распределения все три характеристики — мода, медиана и

средняя совпадают. Этот результат интуитивно совершенно ясен. Читатель

может сам убедиться, что для несимметричных распределений

подобное утверждение не имеет места. (Можно рассмотреть, например,

переменную Ху определенную как квадрат числа выпавших гербов при двух

бросаниях монеты. Значениями X будут числа 0, 1 и 4, а им

соответствуют вероятности 1/4, 1/2 и 1/4; ожидаемое значение будет равно 1,5,

в то время как и медиана, и мода равны 1.)

Помимо сведений о «среднем» или «типичном» значении

вероятностной оценки, полезно знать что-то о «разбросе», или «рассеянии», около

этой величины. Как и для «средней» можно указать различные

числовые меры разброса. Здесь мы рассмотрим лишь некоторые из них. В

качестве одной из наиболее очевидных мер рассеяния можно указать

длину некоторого а-процентного вероятностного интервала. Так, если 95-

процентный вероятностный интервал переменной X имеет длину