Автор: Балакришнан А.В.

Теги: теория вероятностей и математическая статистика теория вероятностей математическая статистика комбинаторный анализ теория графов математика

ISBN: 5-03-000971-Х

Год: 1988

Текст

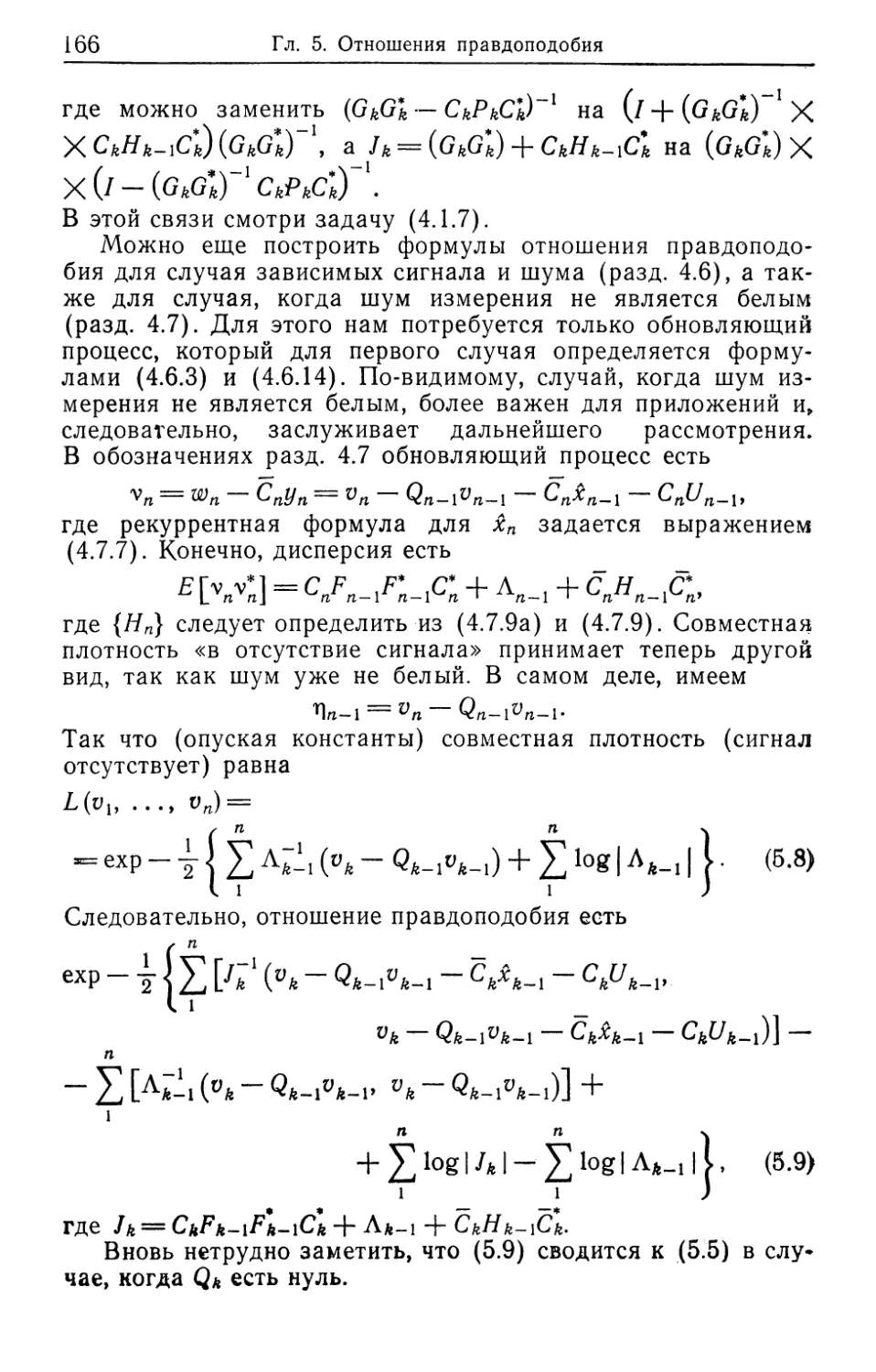

А.В. Балакришнан

Теория

фильтрации

ЗЕ

Калмана

Издательство «Мир»

Теория фильтрации Калмана

A. V. Balakrishnan

Kalman Filtering Theory

Optimization Software, Ino.,

Publications Division, New York

А.В. Балакришнан

Теория фильтрации

Калмана

Перевод с английского

С. М. Зуева

под редакцией

А. А. Новикова

Москва «Мир» 1988

ББК 22.172

Б20

УДК 519.2

Балакришнан А.

Б20 Теория фильтрации Калмана: Пер. с англ.— М.:Мир,

1988. — 168 с., ил.

ISBN 5-03-000971-Х

Книга известного американского математика, содержащая введение в

теорию и методы стохастической фильтрации. В ней дан обзор линейных

систем, изложены основы теории случайных процессов и стохастического оце-

нивания, что упрощает усвоение материала. Книга оригинальна и по струк-

туре изложения, которое строится на рассмотрении фильтра Калмана как ли-

нейной системы. Приведено много задач и примеров, иллюстрирующих теорию.

Для математиков — прикладников, инженеров исследователей, аспиран-

тов и студентов вузов.

1702060000-414

Б----041(01)—88----26~881 Ч‘ 1

ББК 22.172

ped'Q-щия литературы по математическим наукам

ISBN 5-03-000971-Х (русск.)

ISBN 0-911575-26-Х (англ.)

© 1984 by Optimization Software,

Inc., Publications Division, New

York

© перевод на русский язык, с до-

бавлениями, «Мир», 1988

ОТ РЕДАКТОРА ПЕРЕВОДА

А. Балакришнан — профессор Калифорнийского университета в Лос-

Анджелесе, крупный специалист в области теории статистического оцени-

вания и управления динамическими системами. В настоящей книге содер-

жится сжатое и ясное изложение основ теории рекуррентного оптималь-

ного оценивания линейных динамических систем, известной специалистам

как теория калмановскои фильтрации. Она написана весьма неформально

и иллюстрируется рядом наглядных инженерных примеров, которые демон-

стрируют возможности и ограничения этого метода (являющегося, на са-

мом деле, одним из вариантов метода наименьших квадратов).

Основополагающая работа Р. Е. Калмана «О новом подходе к зада-

чам линейной фильтрации и предсказания», появившаяся в журнале

J. of Basic Engineering 27 лет назад, породила огромный поток теоре-

тических обобщений и еще более интенсивный поток прикладных работ

по применению идеи рекуррентного оценивания в различных областях

науки и техники — от космических программ до математических моделей

в медицине. Наиболее полное изложение теоретических основ теории ли-

нейной и нелинейной фильтрации имеется в монографии Р. Ш. Липцера

и А. Н. Ширяева «Статистика случайных процессов» (Наука, 1974).

Из недавних отечественных монографий более прикладного характера от-

метим книгу И. А. Богуславского «Прикладные задачи фильтрации и

управления» (Наука, 1983).

Автор принял активное участие в подготовке русского издания: он

прислал список исправлений и уточнений, а также значительно увеличил

число задач и примеров, позволяющих читателю проверить усвоение ма-

териала и научиться использовать метод на практике.

Книга несомненно будет интересна для читателей, занимающихся

вопросами приложений теории вероятностей и математической статистики.

По уровню применяемого математического аппарата она вполне доступна

студентам технических вузов.

А. А. Новиков

ПРЕДИСЛОВИЕ

Эта книга содержит материал курса лекций половины семестра (или

одного семестра, в зависимости от нагрузки) для студентов старших

курсов инженерных специальностей Предполагается, что читатель знаком

с элементарной теорией пространства состояний систем и элементарной

теорией стохастических процессов (гауссовских второго порядка). Будучи

учебником, книга не претендует на изложение всех известных работ по

данному предмету. Не является она также и справочной книгой. Скорее

она представляет собой цельное изложение ряда логически связанных

лекций, подчеркивающих роль теории и не лишенных практического

смысла. Структура изложения материала основана на более чем деся-

тилетнем опыте преподавания. Развиваются те аспекты теории фильтра-

ции Калмана, которым можно придать строгую математическую основу;

мы стремились избежать подхода, который часто встречается в посо-

биях для профессионалов: «Вот рецепт. Используйте его, он будет рабо-

тать».

Первые две главы содержат обзорный материал по теории простран-

ства состояний и теории сигналов (случайные процессы) — необходимый

здесь, но не достаточный для дальнейшего изучения. Третья глава посвя-

щена статистической теории оценивания; именно на эту теорию опирается

теория фильтрации Калмана. Основной главой является четвертая, в ко-

торой излагается собственно предмет курса. Она начинается с основ теории

и формул (разд. 4.1); мы стремились сделать изложение достаточно об-

щим, чтобы подробности не затемняли смысла, и в то же время достаточно

конкретным, чтобы этот материал имел прикладное значение. Так, мы рас-

сматриваем только случай, когда шум наблюдений является белым и не

зависит от сигнала, но допускаем, что система может зависеть от вре-

мени. Из-за неопределенности начальных значений ковариаций фильтр

Калмана не может быть оптимальным, за исключением случая стационар-

ного состояния — а это наиболее важное его применение. Поэтому

в разд. 4.2 изучаются системы, инвариантные по времени, и рассматри-

вается асимптотическое поведение фильтра. В разд. 4.3 результаты для

стационарного состояния исследуются с точки зрения спектральной теории,

что связывает их с более классическим подходом передаточных функций.

В разд. 4.4 изучается традиционное приложение фильтра Калмана: иден-

тификация систем. В разд. 4.5 рассматривается сглаживающий фильтр

Калмана, т. е. последовательный вариант двухсторонней интерполяции.

В разд. 4.6 и 4.7 сделаны обобщения теории, изложенной в разд. 4.11

в разд. 4.6 сигнал и шум могут быть коррелированными, а в разд. 4.7

шум наблюдений может быть не белым. В разд. 4.8 описан простой при-

мер, который иллюстрирует некоторые аспекты теории и методов, изло-

женных в главе.

Книга завершается главой, посвященной отношению правдоподобия,

где подход с позиции фильтра Калмана играет основополагающую

роль.

Предисловие 7

Во всем изложении мы рассматриваем только модели с дискретным

временем, поскольку все реализации фильтра Калмана предполагают при-

менение цифровых компьютеров

Задачи, помещенные после каждой главы, играют традиционную роль

проверки понимания студентами материала и иногда вторгаются в смеж-

йы& Области.

Рассмотрение моделей с непрерывным временем требует привлече-

ния существенно более сложного математического аппарата (включая тео-

рию стохастического интегрирования и т. п.), но их анализ (получение

явных или асимптотических формул) часто оказывается проще и интуи-

тивно нагляднее, чем для моделей с дискретным временем. См., напри-

мер, [9]. — Прим. ред.

ОБОЗНАЧЕНИЯ

Квадратные матрицы

/ —единичная матрица;

Тг — след;

|Л | —определитель матрицы 4.

Прямоугольные матрицы

4*—матрица, сопряженная и транспортированная к

матрице 4;

[Л, В] = ТгЛВ*

II л 11 = Ум, л]

{аи} — матрица с элементами atj\

Вектор-столбец v: v*v — матрица размера 1X1-

Вектор-строка с: сс* — матрица размерностью 1 X 1-

Самосопряженные матрицы

4 — самосопряженная: А = 4*;

4 — неотрицательно определенная: [Ах, х] О для лю-

бого х

4 В (4 — В) — неотрицательно определенная.

Градиент функции

Если g(0)— скалярная функция 6, то:

градиент g(0) = V0g(0), где

(Veg(9)M = -^g(0 + M) 1х=о>

V0g (бт) — вектор размера 1 X если 0 — вектор раз-

мера tn X 1.

Случайные переменные

Е(-) —математическое ожидание (среднее);

Е(• | •) — условное математическое ожидание (условное

среднее);

Р(-) —функция плотности распределения.

Глава 1

Обзор теории линейных систем

Фильтр Калмана является линейной системой. Данная

глава представляет собой краткий обзор теории линейных

систем с точки зрения «пространства состояний», поскольку

фильтр Калмана лучше всего описывается с этих позиций.

В качестве начального курса теории пространства состояний

читателю рекомендуется монография [2] (см. также [1]*.—

Ред.). Более расширенные курсы можно найти в моногра-

фиях [7], [12], [20], [2]* и других.

Система характеризуется своим «входом», своим «состоя-

нием» и «выходом». Это функции времени. Время может

быть непрерывным или дискретным — в последнем случае

оно указывается целочисленными индексами. В этой книге

мы будем иметь дело только с дискретным случаем.

Пусть {ип} обозначает входную последовательность, а

{vn}—выходную. Тогда для наших целей линейную систему

можно полностью охарактеризовать уравнением «состояние —

вход»

*п+1 = АпХп “Ь BnUn (1’1)

и уравнением «выход—состояние — вход»

~ "Ь Впип, (\1.2)

где Ап— квадратная матрица, а Вп, Сп, Dn — прямоугольные

матрицы. Если размерность пространства состояний равна

р, то Ап имеет размер рХр- Если входная последователь-

ность такова, что каждое ип имеет размерность </Х 1, то раз-

мер Вп будет py^q. Если выходная последовательность та-

кова, что каждое vn является вектором размера mX 1, то Сп

будет иметь размер тХр, a Dn — m\q. Мы можем «ре-

шить» (1.1), (1.2), т. е. выразить значения на выходе через

значение состояния в некоторый начальный момент времени

и значения на входе. Таким образом, считая k начальным

моментом времени, имеем

п-1

i=*k

10

Гл. 1. Обзор теории линейных систем

где k называется переходной матрицей состояний и опре-

деляется следующим образом:

Фп, k = Дг-1 • • • П И

ФЛ, п = 7 (единичная матрица)1). (1.4)

Отметим, что она обладает свойством «переходности»:

К Л, щ = к m, (1.5)

Из уравнения (1.3), которое задает состояние в произволь-

ный момент времени и, п £, легко находится явное выра-

жение для выхода в зависимости от начального состояния и

текущих значений на входе:

п — 1

Vn == ^*пФп, k^k "4“ ^пФп, “И DnUn, (1.6)

i=k

Здесь первый член — отклик на начальное состояние (или

начальное условие) и второй член — отклик на входную по-

следовательность. Функция

I == ^пФ/г, i + \В}, 1<П, (17)

= Dn, i = n, ’ Л

называется «весовой матрицей» или «весовой моделью» си-

стемы.

Инвариантные системы

Нас в основном интересует случай, когда система инва-

риантна относительно времени, т. е. когда все матрицы си-

стемы не зависят от времени:

Л = Л, Вп = В, Сп = С, Dn — D.

Тогда (1.1) и (1.2) принимают вид

•^п+1 == “Ь Вип,

vn = Cxn + Dun.

В этом случае переходная матрица состояния есть

ж! л^—&

*Фм, £ =

Поэтому

xn = An~kxk + Ё (1.9),

i=k

9 Здесь и далее I всегда будет обозначать единичную матрицу не-

зависимо от размера.

Гл. 1. Обзор теории линейных систем

11

•и выражение для выхода принимает следующий вид:

п— 1

vn = CAn~kxk+ S СА'-'-'Вщ + Dun. (1.10)

i=k

Отметим свойство «временной инвариантности»: отклик (со-

стояние или выход) инвариантен относительно любого сдвига

по времени. В частности, начальный момент времени поэтому

обычно принимают равным нулю, т. е. £ = 0 в (1.9), (1.10).

Весовая матрица системы зависит только от разницы времен:

rrtiZ = CA'l-1“fS, n>i;

= D, п = i.

Теперь удобнее записать

Wk = CAkB, 6>0.

Тогда для (1.10) получаем

п— 1

= САпх0 + £ ^п-1-iUt + Dun,

о

Можно объединить второй и третий члены и записать

vn = CAnx0+ Е ю&п-ь (1.10а)

о

полагая = W/^1; wt — D, i = 0.

Из многих свойств, характеризующих инвариантные си-

стемы, определенные равенством (1.8), наибольший интерес

для нас представляют три:

(1) устойчивость;

(2) управляемость;

(3) наблюдаемость.

Рассмотрим последовательно каждое из них.

Устойчивость

Будем говорить, что состояние х (хе Rp — линейное про-

странство (рX 1)-матриц) устойчиво (или «Л-устойчиво»),

если

ИтДЛх = 0. (1.12)

п

По отношению к (1.9) это означает, что член, соответ-

ствующий начальным условиям в этом выражении, будет

асимптотически обращаться в нуль. То же верно и для (1.10).

12

Гл. 1. Обзор теории линейных систем

Класс всех устойчивых состояний является линейным подпро-

странством. Назовем его устойчивым подпространством. Си-

стема является устойчивой, если все ее состояния устойчивы.

Для устойчивости системы необходимо и достаточно, чтобы

все собственные числа матрицы А были по модулю строго

меньше 1. В этом случае говорят также, что матрица А устой-

чива. Отметим, что А является устойчивой, если А*А устой-

чива; при этом обратное неверно.

Для устойчивой системы весовую матрицу системы мож-

но охарактеризовать преобразованием Фурье, называемым

«передаточной функцией» входа — выхода:

iHM = Е = D + е2лас £ Ake2nlkKB, —1/2 < Л < 1/2.

О о

Пусть z — комплексная переменная. Тогда ряд

Е wkzk

О

сходится для |z|^ 1 и называется ^-преобразованием. Из

(1.11) сразу получаем, что

Yiwkzk = zC(,I-zA)~i B + D, И<1. (1.14)

О

Все свойства z-преобразования могут быть получены из пе-

редаточной функции:

•ф(Л) = С(7 —е2ягМ)_1Ве2"(Х + £>, —1/2 < Я, <1/2. (1.15)

Заметим, что ^-преобразование (1.14) остается определен-

ным даже для неустойчивых А при | z | <Z г, где г — некото-

рое число г, 0 < г 1.

Управляемость

Скажем, что состояние х управляемо (лучше было бы

сказать достижимо), если оно может быть достигнуто из на-

чального состояния за некоторое конечное число шагов по

времени при соответствующем входе. Более точно, состояние

х управляемо, если для некоторого п и некоторой последова-

тельности {щ}

хо = О,

= Axk + Buk, О k п — 1,

ля = х.

Гл. 1. Обзор теории линейных систем

13

Это эквивалентно тому, что выражение (1.9) для произволь-

ного момента времени имеет вид

п— 1

х = £ Ап~1~кВик. (1.16)

£=0

Управляемые состояния образуют линейное подпростран-

ство, которое назовем «управляемым подпространством».

Когда оно совпадает со всем пространством состояний, гово-

рят, что пространство состояний управляемо. Будем обозна-

чать это сокращенно: «(Л — В) управляемо».

Необходимым и достаточным условием управляемости яв-

ляется то, что (составная) матрица управляемости

\В АВ ... Л₽~’в| (1.17)

имеет полный ранг. Или, что эквивалентно, матрица размера

рХр

Rc^'L А1 ВВ*А*1

О

невырожденная. (Напомним, что А имеет размер рХр) Бо-

лее того, подпространство управляемых состояний в точности

есть область изменения /?с.

Если пространство состояний управляемо, мы можем вы-

разить выход vn единственным образом через предшествую-

щую входную последовательность. Действительно, для неко-

торого k имеем

£-1

хо — S ^BUk^i-p

о

и можем переписать это, обратив время, как

-1

*о= S A~x4Buh

i=-k

где

un = uk+h — 1.

Другими словами, мы можем найти начальное состояние Хот

которое можно рассматривать как результат воздействия на

систему подходящей входной последовательности в предыду-

щие моменты времени. Более того, мы можем записать теку-

щее состояние хп в следующем виде:

—1 п-1 п-1

хп —Ап £ Л~1-/ВЫ/+Е Лп-1-/Ви/ = Л Лп-1"‘Вй,,

i--k i-0 i-.-k

14

Гл. 1. Обзор теории линейных систем

где

щ = uh 0 < i < п — I;

щ — Щ, — k < i --1.

Далее можно переписать это в «типичной» форме

п — 1

хп = У, Ап~х~‘Ви{,

i= — оо

где входная последовательность Ui является нулевой для

—оо < i —2V. В свою очередь вход можно выразить в виде

П— 1 оо оо

22 ^-i-л "Ь вип 22 w ]Un_1—/ оип 22 -j'•

— оо О О

(1.18)

Другими словами, вследствие управляемости выход пол-

ностью выражается через вход, без введения в рассмотрение

состояния. Кроме того, можно получить, отправляясь от

(1.18) (хотя это выходит за рамки данного рассмотрения),

такое описание в терминах пространства состояний, при ко-

тором пространство состояний является управляемым.

Замечание. Из (1.10а) видно, что если система устойчива,

то первый член в (1.10а) стремится к нулю при больших п,

так что представление (1.18) асимптотически справедливо

для устойчивых систем.

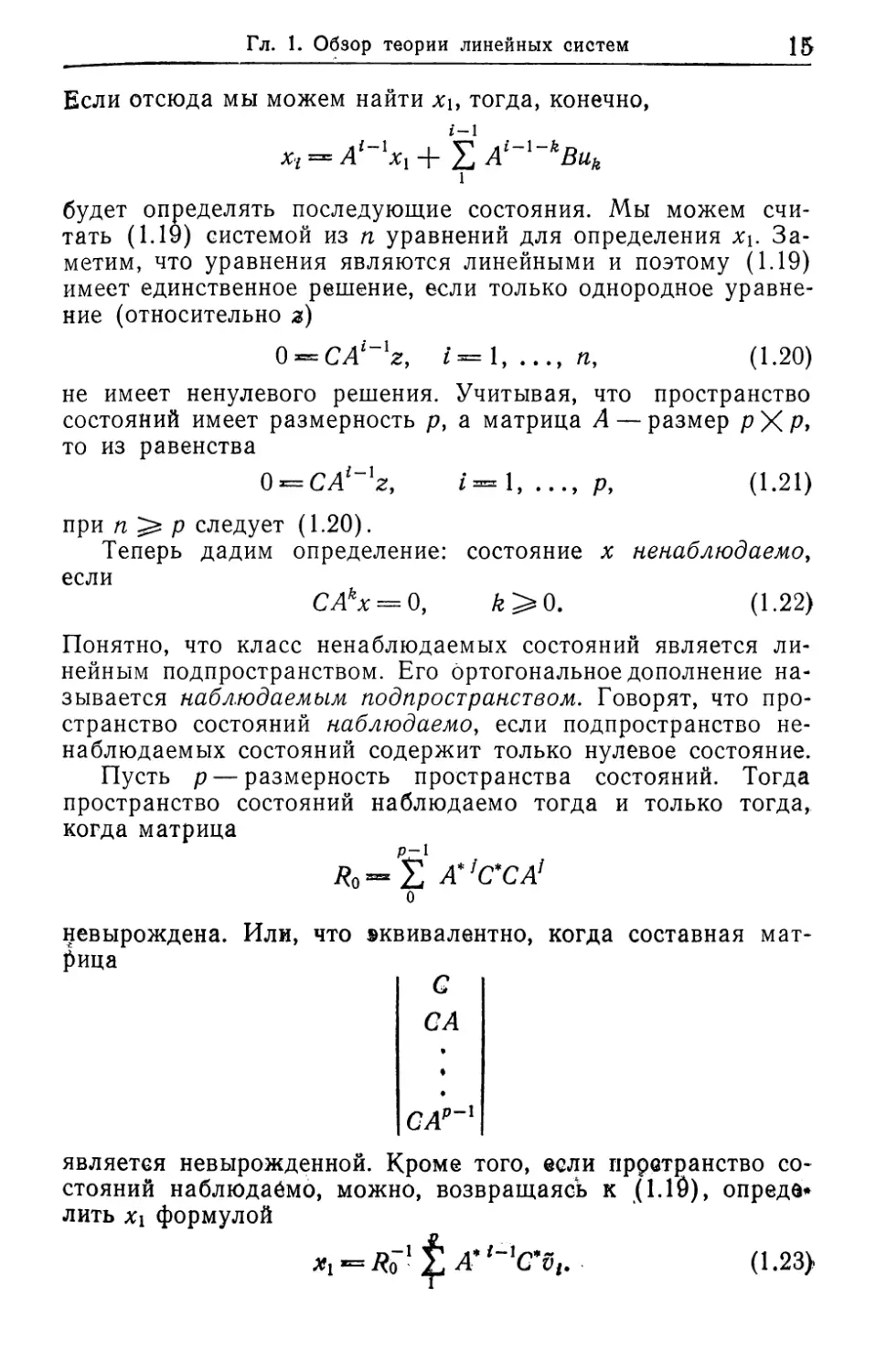

Наблюдаемость

Чтобы ввести понятия наблюдаемости, начнем с рассмот-

рения задачи, имеющей определенное практическое значение.

Предположим, что система известна, т. е. 4, В, С и D за-

даны. Будем также считать заданной последовательность пар

(Ui,Vi), i = 1, ..., п, где щ — вход и Vi — выход. Можем ли

мы определить состояния Xi, хп, соответствующие этим

данным? Чтобы ответить на этот вопрос, можно поступить

следующим образом.

Поскольку

Z-1

vl — CAi~lx1 + Е СА{~х~кВик, 1=1,..., п,

1

то, вычитая отклик на известный вход и полагая

vt = vt — СА1~х~кBuk,

1

имеем

щ = СА1~ххь г = 1......п. (1.19)

Гл. 1. Обзор теории линейных систем

15

Если отсюда мы можем найти хь тогда, конечно,

i-1

x-i = А1~ххх + X Al~x kBuk

1

будет определять последующие состояния. Мы можем счи-

тать (1.19) системой из п уравнений для определения хь За-

метим, что уравнения являются линейными и поэтому (1.19)

имеет единственное решение, если только однородное уравне-

ние (относительно з)

0==СЛг-1г, Z=l, (1.20)

не имеет ненулевого решения. Учитывая, что пространство

состояний имеет размерность р, а матрица А — размер р X Р,

то из равенства

0 = CXf-Iz, t==l, .р, (1.21)

при р следует (1.20).

Теперь дадим определение: состояние х ненаблюдаемо,

если

CAkx = Q, /г>0. (1.22)

Понятно, что класс ненаблюдаемых состояний является ли-

нейным подпространством. Его ортогональное дополнение на-

зывается наблюдаемым подпространством. Говорят, что про-

странство состояний наблюдаемо, если подпространство не-

наблюдаемых состояний содержит только нулевое состояние.

Пусть р — размерность пространства состояний. Тогда

пространство состояний наблюдаемо тогда и только тогда,

когда матрица

— А*‘с* С А1

о

невырождена. Или, что »квивалентно, когда составная мат-

рица

G

СА

САР"'

является невырожденной. Кроме того, если пространство со-

стояний наблюдаемо, можно, возвращаясь к (1.10), опреде*

лить xi формулой

*1 = Яо-1£ (1.23>

16

Гл. 1. Обзор теории линейных систем

Мы также воспользуемся записью «(С ~ Л) наблюдаемо»

для обозначения того, что пространство состояний наблю-

даемо. Заметим, в частности, что (С ~ А)-наблюдаемость

эквивалентна (А* ~ С*)-управляемости.

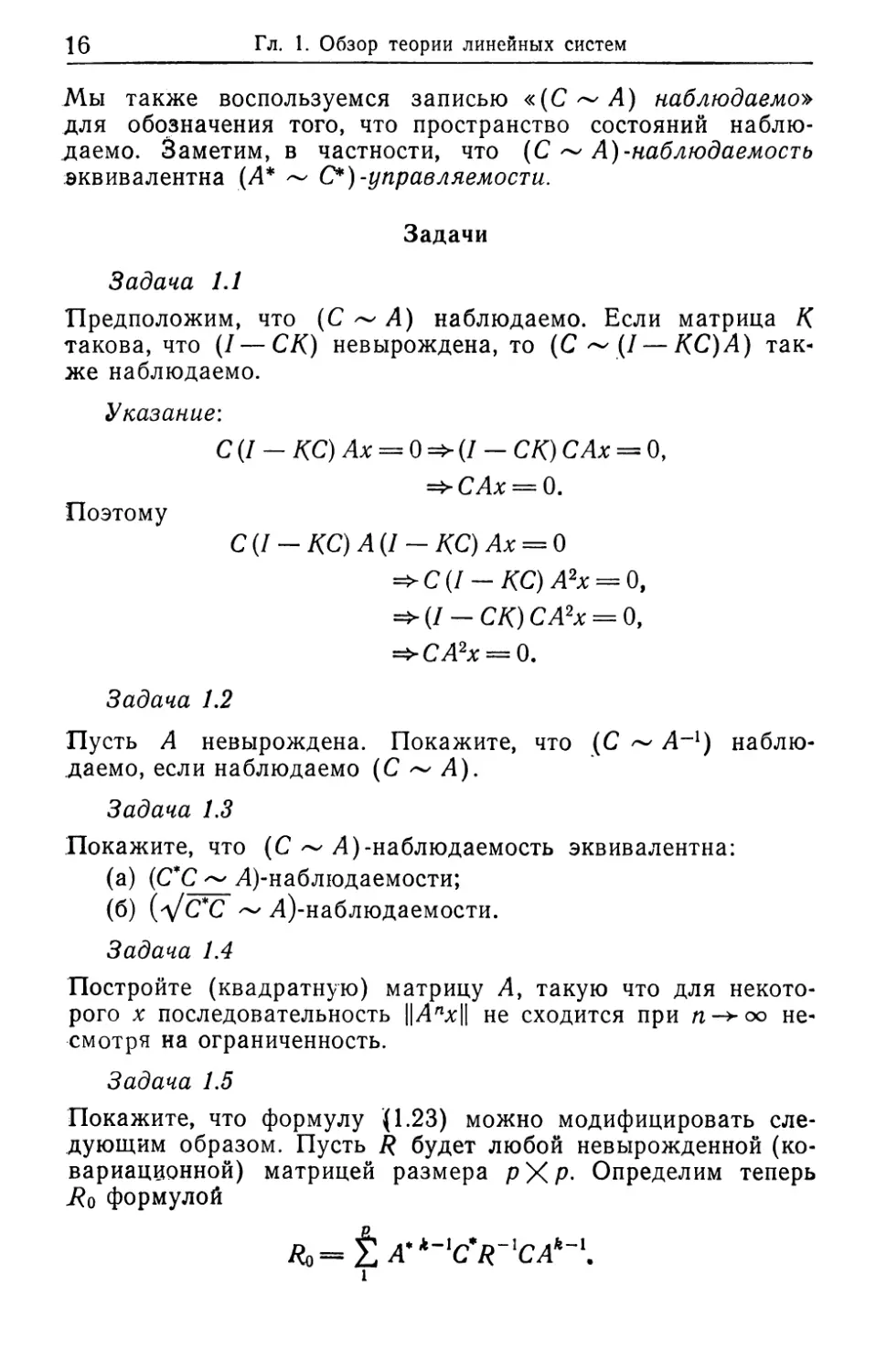

Задачи

Задача 1.1

Предположим, что (С ~ А) наблюдаемо. Если матрица К

такова, что (/ — СК) невырождена, то (С ~ (7 — КС) А) так-

же наблюдаемо.

Указание:

С(1 — КС) Ах = 0=>(1 — СК) С Ах = О,

=>САх = 0.

Поэтому

С (/ - КС) А(1 — КС) Ах = 0

=>С(1-КС) А2х = 0,

=>(/ -СК) СА2х = 0,

=>СА2х = 0.

Задача 1.2

Пусть А невырождена. Покажите, что (С ~ А-1) наблю-

даемо, если наблюдаемо (С ~ А).

Задача 1.3

Покажите, что (С ~ А)-наблюдаемость эквивалентна:

(а) (С*С ~ А)-наблюдаемости;

(б) (д/С*С ~ А)-наблюдаемости.

Задача 1.4

Постройте (квадратную) матрицу А, такую что для некото-

рого х последовательность ||Алх|| не сходится при м->оо не-

смотря на ограниченность.

Задача 1.5

Покажите, что формулу (1.23) можно модифицировать сле-

дующим образом. Пусть R будет любой невырожденной (ко-

вариационной) матрицей размера рХр« Определим теперь

формулой

Ro= i A*lt~lC,R~'CAk~l.

1

Задачи

17

Тогда получим представление

1

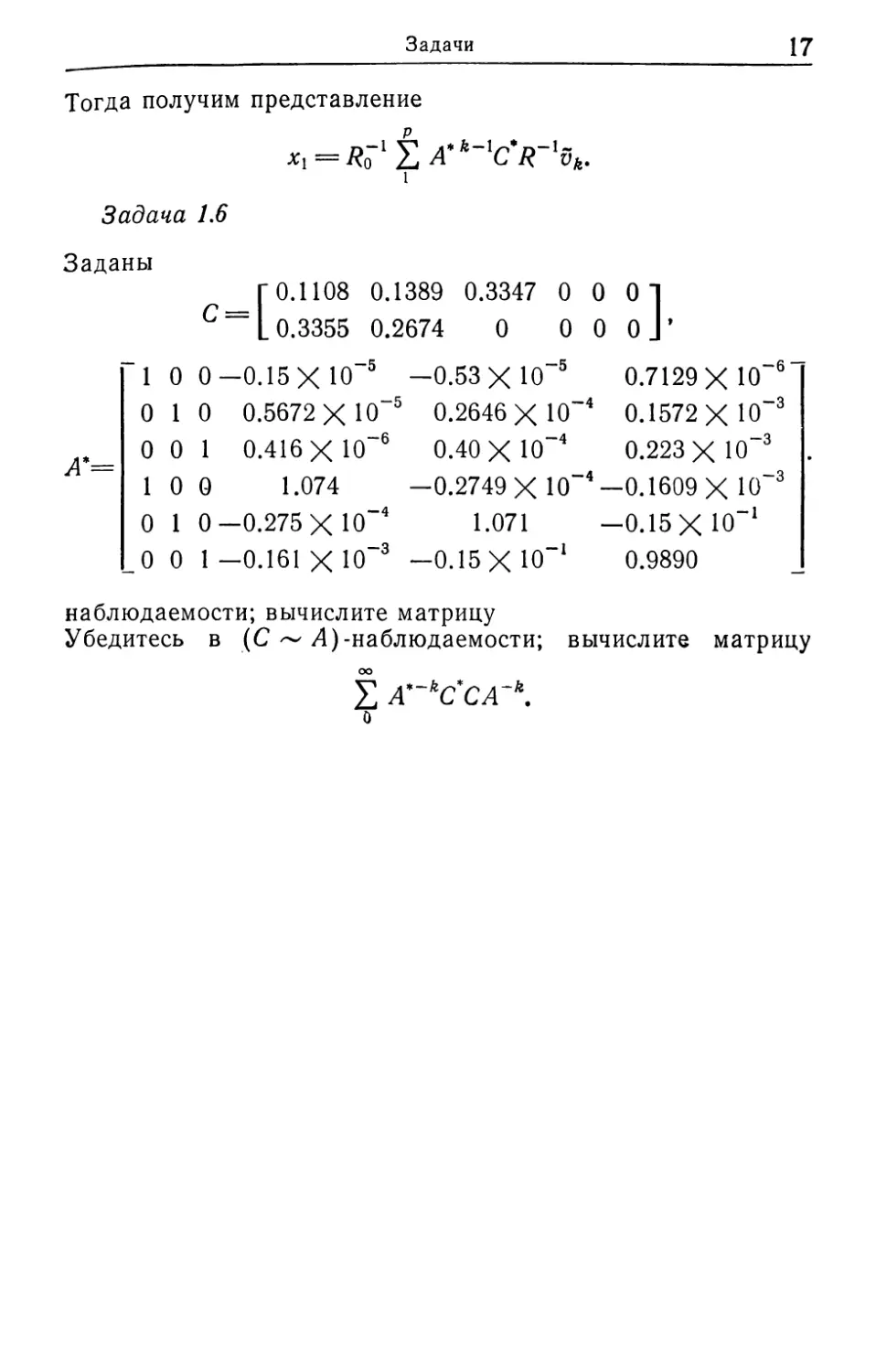

Задача 1.6

Заданы

_ Г 0.1108 0.1389 0.3347 000]

C=L 0.3355 0.2674 0 0 0 oj’

”1 0 0—0.15 ХЮ-5 —0.53 ХЮ-5 0.7129 ХЮ-6

0 1 0 0.5672 ХЮ-5 0.2646 ХЮ-4 0.1572 ХЮ-3

= 00 1 0.416 ХЮ-6 0.40 ХЮ-4 0.223 ХЮ~2 3

— 1 0 0 1.074 —0.2749 X Ю~4—0.1609 X Ю“3

0 1 0—0.275 ХЮ-4 1.071 -0.15 ХЮ-1

_0 0 1—0.161 ХЮ-3 —0.15 ХЮ-1 0.9890

наблюдаемости; вычислите матрицу

Убедитесь в (С ~ Д)-наблюдаемости; вычислите матрицу

2 А'~кССА~к.

о

Глава 2

Обзор теории сигналов

В этой главе мы приведем краткий обзор основных фак-

тов, касающихся понятия сигнала, которые потребуются в

дальнейшем. Для более детального изучения, включая под-

робности доказательств, можно рекомендовать работы [13],

[14], [17], [18], [19].

Как и в случае систем гл. 1, будем рассматривать только

дискретное время, т. е. случай, когда независимая перемен-

ная может принимать лишь целые значения. Таким образом,

мы будем использовать обозначение sn для п-го выборочного

значения, считая от некоторого (произвольного) начального

измерения (времени). (Выборочные значения не обязательно

должны браться через равные промежутки времени, хотя это

наиболее распространенная ситуация.) Будем считать sn век-

тором-столбцом размера т\1. Поскольку начальный мо-

мент времени произволен, мы допускаем, если потребуется,

как положительные, так и отрицательные значения п. Хотя и

невозможно в каком-либо физическом устройстве обработать

неограниченное число выборочных значений, но было бы

столь же нереалистично ограничивать число выборочных зна-

чений неким раз и навсегда фиксированным числом. По-

этому мы идеализируем наши сигналы, рассматривая их как

необрывающиеся последовательности вида {srt}> где л = L

2, ... пробегает все целые положительные значения (или,

если необходимо, то и целые отрицательные).

Спектральная теория сигналов с конечной

энергией

Скажем, что последовательность сигнала1) {$л} имеет ко-

нечную энергию, если

lim Е ||sn ||2 < оо.

2V->oo — N

Это понятие и связанная с ним теория нам почти не потре-

буются. Будем говорить, что сигнал {sn} имеет конечную

В дальнейшем будем писать просто «сигнал», опуская слово «по-

следовательность».

Гл. 2. Обзор теории сигналов

19

мощность, если

N

Нт У SnSn = Ps<oo.

2N st

(2.1)

Фактически мы будем требовать несколько больше, чем (2.1).

Приведенное ниже предположение в технической литературе

обычно подразумевается выполненным. Так, следуя фунда-

ментальной работе Винера [18], мы будем предполагать, что

предел

w

Нт 9л/ У $п$п+т == Rm

—N

существует и конечен для каждого m 0. Это утверждение

не следует с необходимостью из (2.1)1 Отметим, что

= 2¥ £ = >7 2F Е $Л-т = R-m- (2-2)

-W — N

Конечно,

RO = PS (ковариация сигнала).

Типичным примером сигнала с конечной мощностью является

sn = a cos (2лпХ0 + 6),

который является периодическим, если %0 рациональное число.

В этом случае

N

Rm = аа* lim У cos (2лпЛ0 + 0) cos (2л (п + пг) Ло + 0) =

-N

= (аа*) ~ cos 2лтЛ0, Ло =/= 0.

Заметим, что

1/2

Rm = J e2«am(^.)(d(A_M + d(x + xo))dx>

-1/2

и для Хо =# 0 это выражение не зависит от «фазового угла» 0.

Этот результат можно обобщить. В действительности имеет

место теорема Бохнера — Хинчина — Винера о спектральном

представлении:

1/2

Rm= J e^ps(tydk, (2.3)

-1/2

20

Гл. 2. Обзор теории сигналов

где р$(Х)— самосопряженная, неотрицательно определенная

функция, известная как спектральная плотность сигнала (ко-

торая, конечно, может содержать дельта-функции). Действи-

тельно, ее можно получить разложением в ряд Фурье:

PsW=te-2niKmRm, (2.4)

— оо

где {Rm} есть коэффициенты Фурье для р$(Х). Из (2.4) по-

лучаем, что

PsW* = Ps(+ V-

Пусть такой сигнал {sn} является входом линейной системы

с передаточной функцией ф(Х). Пусть {ип} обозначает соот-

ветствующий выход, так что

оо п

= Е Wksn_k = X wn_ksk,

0 —оо

Ф W = S wke2nikK, £ II wk II2 < оо.

о о

Тогда

N оо оо . N .

TTTF / = / / Wb I 77TF / ь$* w , IW*.

2N / 1 п п+т / 1 / 1 й I 2/v / n—k n+m—j I i*

— N 0 0 \ -W /

и, переходя к пределу при Af->oo, получаем

N оо оо

Rv= lim тит V = V V wbR.b ,w* =

tn 2N l—i n n+tn / j 2—j « 'm+fe—/ ]

2V‘>O° _/v 0 0

_ e2ni\mf^^ wke2niKkps (A) e~~2jlZA,^A dk =

-1/2 \ о о /

1/2

= e2niKm^ ps «ф* (h) dK

-\/2

'(где * означает сопряжение и транспонирование). Другими

словами, выход {ип} имеет «усредненные по времени» свой-

ства, аналогичные свойствам входа {$л}, и спектральная

плотность выхода имеет вид

= (2.5)

В частном случае, когда система имеет структуру

vn = Схп,

х -Ах +Fs (2-6)

Лп+1 “Г Гдп,

Гл. 2. Обзор теории сигналов

21

мы видим (предполагая, что А — устойчивая матрица), что'

о

где теперь

а|) (Л) = J CAke2niKkF = С(1 — Ае2ла)~1 F.

О

Следует отметить, что в отличие от (1.13) теперь D = 0.

Именно эту форму мы будем использовать в дальнейшем.

Таким образом, для спектральной плотности имеем сле-

дующее представление:

ро (Л) = С(1- Ле2яЛ)-1 Fps (Л) F* (I - А*е~2л‘^)~1 С*. (2.7)

Стохастические сигналы: теория процессов

второго порядка

В своей основополагающей работе [18] Винер использо-

вал для описания сигналов теорию, кратко изложенную в пре-

дыдущем разделе этой главы. Эта теория является «стацио-

нарной». Можно построить более общую теорию, которая поз-

волит включить анализ «переходных» или «неустановившихся

состояний» и в то же самое время сделает более простым

анализ стационарных состояний. Это достигается введением

в рассмотрение стохастических сигналов, включая теорию

«генерации сигнала», которая позволяет построить сигнал с.

заданной спектральной плотностью.

Стохастический сигнал представляет собой случайный про

цесс (или временной ряд) в виде последовательности случай*

ных переменных, для которых совместное распределение лю-

бого порядка задано (или в принципе может быть вычисле-

но). Гауссовский случайный сигнал — это такой сигнал, для

которого все совместные распределения являются гауссовски-

ми. В теории фильтрации Калмана достаточно рассматривать

только гауссовские сигналы. Вообще говоря, в линейной тео-

рии фильтрации мы будем иметь дело лишь с моментами до>

второго порядка включительно (средние и ковариации), и по-

этому для нас будет представлять интерес лишь теория вто-

рого порядка. С другой стороны, можно заменить любой дан-

ный процесс гауссовским с теми же значениями средних и

ковариаций и, следовательно, можно ограничиться только

гауссовскими процессами 9.

° Имеются в виду, конечно, только линейные задачи теории случай-

ных процессов. — Прим, ред.

22

Гл. 2. Обзор теории сигналов

Скажем, что стохастический сигнал {s„} является стацио-

нарным (во втором порядке), если E[sn] не зависит от п (где

здесь и далее £[•] обозначает математическое ожидание, или

среднее по ансамблю) и если ковариация

£ [К - £ IW £

Другими словами, «сдвиг по времени» не приводит к каким-

либо изменениям. В частности, если процесс гауссовский, то

функции плотности распределения также инвариантны отно-

сительно «сдвига по времени», т. е.

P(sn> ^л + 1» •••> ^п + р) = Р + ^n + zn+b •••> + р +

для всех п, т, р. Для процессов, стационарных во втором по-

рядке, мы вновь имеем теорему Винера — Хинчина — Бохнера

[И]:

1/2

Rm = J e2^p(K)dK

-1/2

где р(Х)—спектральная функция плотности процесса. (Она

может содержать 6-функции, т. е., более строго,

1/2

Rm = J e2nimK dP (к),

-1/2

где Р(Х) называется спектральным распределением.) В слу-

чае, когда

dP (Х) = р(Л) dk

(т. е. процесс имеет спектральную плотность), она может

быть определена рядом Фурье:

— оо

Отметим, что р(Х) является самосопряженной и неотрица-

тельно определенной. Кроме того,

р(- Л) = Е e~2nimKR'n

так что

Ра (М = Ра ( О,

где Ри(Х) обозначает диагональные элементы. Задача оцени-

вания р(Х) по одной «длинной» реализации процесса из-

вестна как «задача спектрального оценивания» и имеет важ-

ное значение, но выходит за рамки данной книги.

Гл. 2. Обзор теории сигнал^,

2»

Заметим теперь, что спектральная теория сигналов с ко-

пий энергией, с которой мы начали, сильно похожа на

Не₽ктоальную теорию стохастических сигйалов. ды уточним

СПе гнязь обратясь к центральному резуЛьтату эрГодической

8Т\иИ Он СОСТОИТ В ТОМ, ЧТО ДЛЯ стациойарного ГауССОВСКОГО

Тпппесса с непрерывной спектральной Функцией распределе-

ния среднее по ансамблю реализации м<)Жет быть заменено

апрпним по времени.

Р Таким образом, если спектральное распределение не имеет

„пв (или на техническом языке, сп^Тральная плотность

не содержит дельта-функций), то1)

ДО

E[f(sn)] = Km

До->°о -N

И, В частности, N

E[sn]= V™

N-*°° _N

Кроме того, #

Rn = £ [SnSn+m] 2У ХМм-т’

Таким образом, мы можем считать сигн^ эргодическим гаус.

совским процессом, т. е. «среднее по врейени> понимать как

среднее по ансамблю или среднее статиоъ!{еское

Пусть стационарный (с нулевым ^ним)’ гауссовский

сигнал {s„} со спектральной плотностью явл/ется вхо.

дом инвариантной по времени линеиноийсте^ы и п , ।

является выходом, так что * J 1 п>

•оо

Vn = Е WK-fe.

О

Тогда выход {ц„}-также гауссовский с^0она ный с.

со спектральной плотностью pv (X): г г

Pv W “ Ф W Ps W Ф* ft

где

-ф (%) = wke2nikK (предполагается, ||Шл||««< оо).

о Здесь и далее мы будем опускать термин^ верОЯТНостью едини*

Ца» для всех равенств, включающих в себя переменные.

24

Гл. 2. Обзор теории сигналов

Это можно доказать по существу так же, как и в детермини-

рованном случае, но только с использованием среднего (ста-

тистического) по ансамблю:

оо оо

Е М+J = £ £ wkE k-X+m-/] =

о о

= У У wk e2niK (Л) =

О О -1/2

1/2

= J е2ШтК^ (Л)р5(Л)1|)*(Х)ЙХ.

-1/2

В частности, (2.7) справедливо, когда система имеет вид (2.6) .

Модели генератора сигнала

Гауссовский сигнал {Nn}, такой что

ЖМ,

Е [Л/’пЛ^ш] = 0, п #= /п,

= /, п = т,

называется белым шумом с единичной ковариацией. Пусть

Sn ПХ'ПУ

х -Ax+FN п>0 (2-8)

хп + 1 — Лпхп \ Г П[У1 ПУ

Эта система является моделью генерации сигнала {sn}»

я такой способ генерации известен как «прохождение белого

шума через линейную динамическую систему». Оказывается,

что для всех практических целей лишь этот класс сигналов

представляет интерес в теории фильтрации.

Теперь изучим некоторые свойства процесса {srt}, генери-

руемого таким образом. Предположим, что х0 является гаус-

совским и не зависит от шума {Nn} п 0. Тогда процесс

{хЛ}, процесс изменения состояния, является гауссовским и

марковским. Поэтому мы без труда можем установить, что

В [хЛ | Хр, Xp_j, . . ., Xq] == Е [хп I хр1*

Действительно, достаточно заметить, что в решении (2.8)

-Хд = Ап- 1 ... Архр -f- Fn^Nn—i +

+ An^An^2Fп-зМп-з + ... + At-iAi-2 • • • ApFpNp,

Гл. 2. Обзор теории сигналов

25

причем члены с шумом в правой части не зависят от хр. Это

вновь означает, что вся память о процессе сосредоточена в

состоянии, отстоящем от данного на один шаг назад.

Теперь вычислим средние и ковариацию {$л}. Имеем

Е [$/г] = СпЕ [Хп],

Е 1Л/г] == [%п—1] = ^п-1 • • • AyE [*<)].

В частности, sn имеет нулевое среднее, если начальное состоя-

ние х0 имеет среднее, равное нулю.

Исследуем структуру ковариаций. Для простоты будем

предполагать, что

Е [х0] = О,

так что

£ [хп] = 0, п 0.

(В противном случае мы можем ввести центрированный про-

цесс

= Е »

который будет удовлетворять той же динамике и иметь нуле-

вое среднее.)

Полагая

R(m, n) = £[xm<],

имеем

R(n + p, ri) = An+p_l ... AnR(n, n),

и R(n, n) удовлетворяет равенству

R (n 4- 1, n + 1) = AnR (n, ti) An + FnFn,

R(0, 0) = £[V;j. (2-9>

Для ковариации сигнала таким образом получаем

Для нас особо интересен случай системы, инвариантной по»

времени, когда

Л = Л, Fn = F, Сп = С.

Тогда имеем

(тг, п) = R(m — п) = Am~nR (п, п)9 т^п,

при этом

/?(п, п) = Л£(п-1, п- 1) А* + FF\ (2.Ю)

26 Гл. 2. Обзор теории сигналов

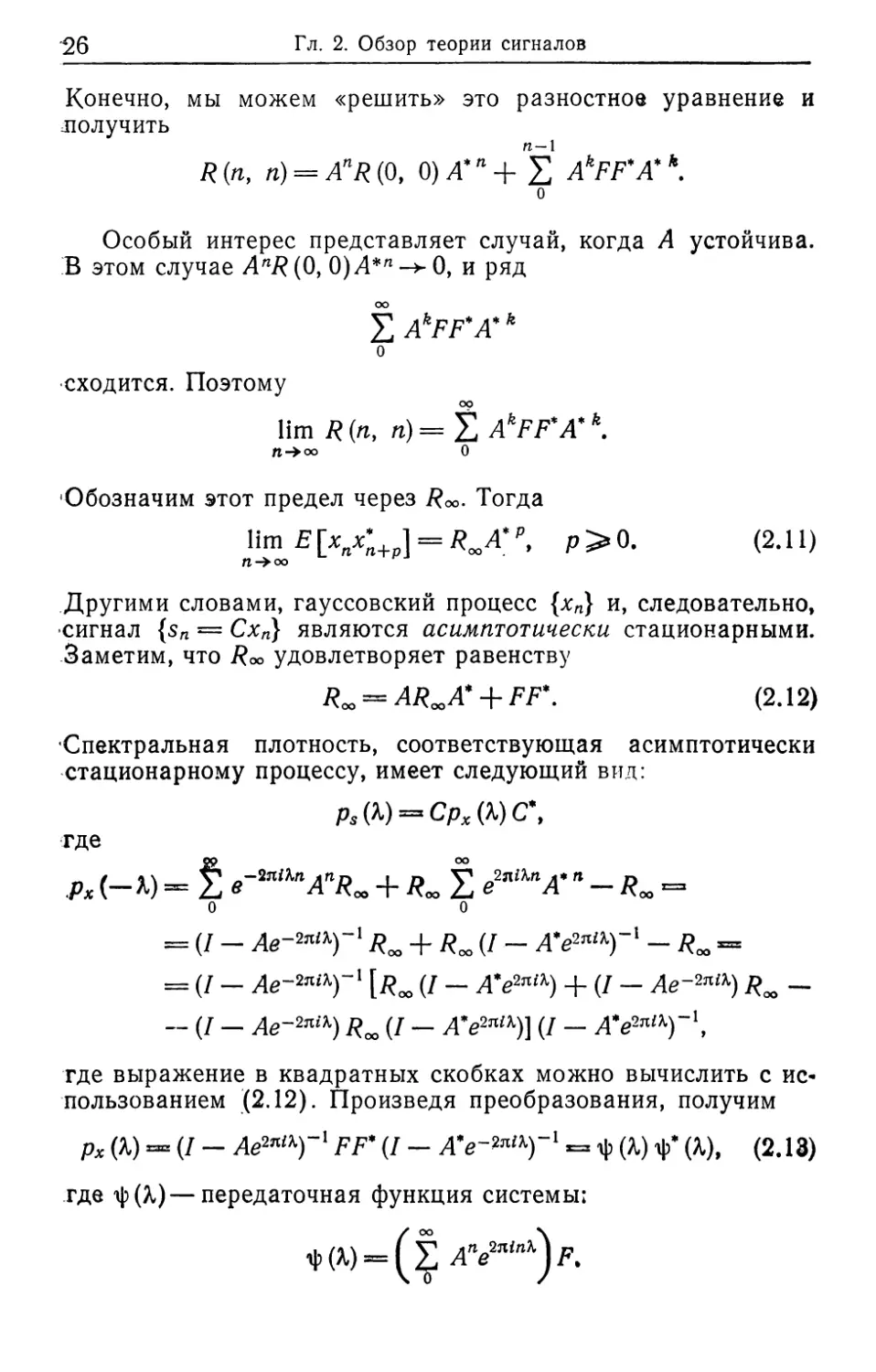

Конечно, мы можем «решить» это разностное уравнение и

лолучить

R(n, n) = AnR(Q, 0)А’п+ Ё AkFF*A*h.

О

Особый интерес представляет случай, когда А устойчива.

В этом случае AnR (0, 0) А*п -> 0, и ряд

£ AkFF'A*k

о

сходится. Поэтому

lim R (п, п)=^4 AkFF*A*k.

П->оо 0

Обозначим этот предел через /?оо. Тогда

ПтЧ*Х+Р] = /М‘₽, Р>0. (2.11)

П оо

Другими словами, гауссовский процесс {хл} и, следовательно»

сигнал {sn = Схп} являются асимптотически стационарными.

Заметим, что Roo удовлетворяет равенству

ROO = AROOA* + FF\ (2.12)

Спектральная плотность, соответствующая асимптотически

стационарному процессу, имеет следующий вид:

Ps W = СРх (X) С ,

где

рх (-*) = S e~2niKnAnRa> + RM f e2"iXnA*п - Rx =

о о

= (Z - Ae~2ntK)~l R” + Roo U - А'е^Г* - RM -

= (/ — Ae~2™T‘ [Roo (Z ~ A*e2niK) + (Z - Ае~2л1К) Rx —

- (Z - Ае~2ла) RM (I - A*e2n/K)] (I - A*e2nlK)~',

где выражение в квадратных скобках можно вычислить с ис-

пользованием (2.12). Произведя преобразования, получим

рх (X) =ш= (z — Ae2JlU)-1 FF* (Z - = -ф (Л) ф’ (Л), (2.18)

где ф(Л)—передаточная функция системы:

Гл. 2. Обзор теории сигналов

27

В частности, имеем следующее «разложение» для спектраль-

ной плотности сигнала:

psW4^(WW,

где является передаточной функцией «физически реа-

лизуемой взвешенной модели».

В заключение отметим, что для устойчивой системы (т. е.

когда матрица А устойчива) можно показать, что среднее по

времени равно среднему по ансамблю (в стационарном со-

стоянии):

N

lim 4- У s.s* = CAPRC*.

п = 1

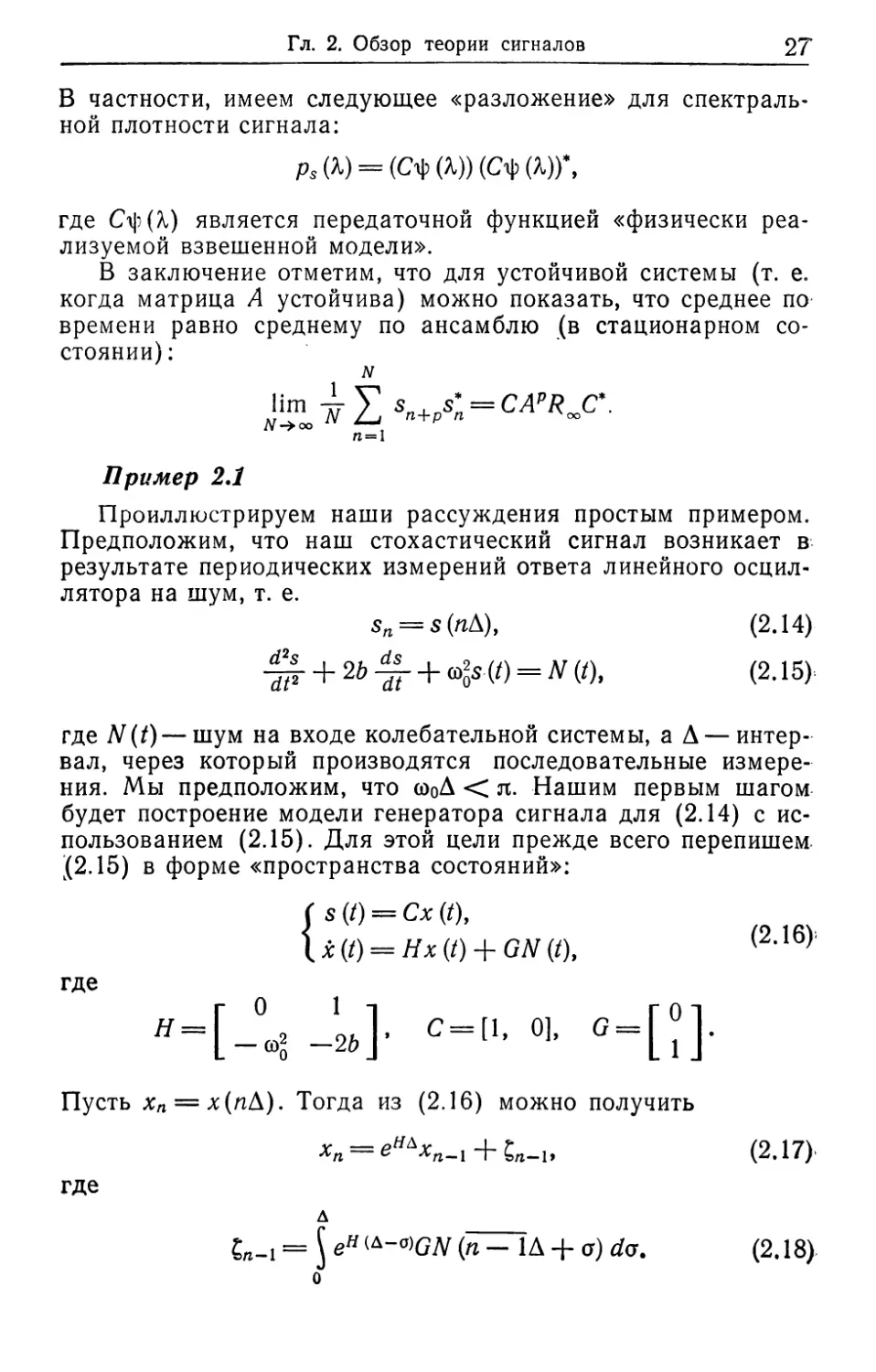

Пример 2.1

Проиллюстрируем наши рассуждения простым примером.

Предположим, что наш стохастический сигнал возникает в

результате периодических измерений ответа линейного осцил-

лятора на шум, т. е.

sn = s(nA), (2.14)

+ 2& -g- + (0^ (t) = (0, (2.15)

где N(t) — шум на входе колебательной системы, а Л — интер-

вал, через который производятся последовательные измере-

ния. Мы предположим, что (о0Л < л. Нашим первым шагом

будет построение модели генератора сигнала для (2.14) с ис-

пользованием (2.15). Для этой цели прежде всего перепишем

(2.15) в форме «пространства состояний»:

(s(t)-Cx(t),

1 х (/) = Ях (/) 4-GAT (/), (2,16):

где

г 0 l-i Г01

Н = 2 0. . С=[1, 0], G= u .

L - <°о ~2b J L i J

Пусть xn = х(пД). Тогда из (2.16) можно получить

xn = e^xn_l + ^-l, (2.17).

где

д

ен ^GN (п- 1Д + a) da. (2.18)

28

Гл. 2. Обзор теории сигналов

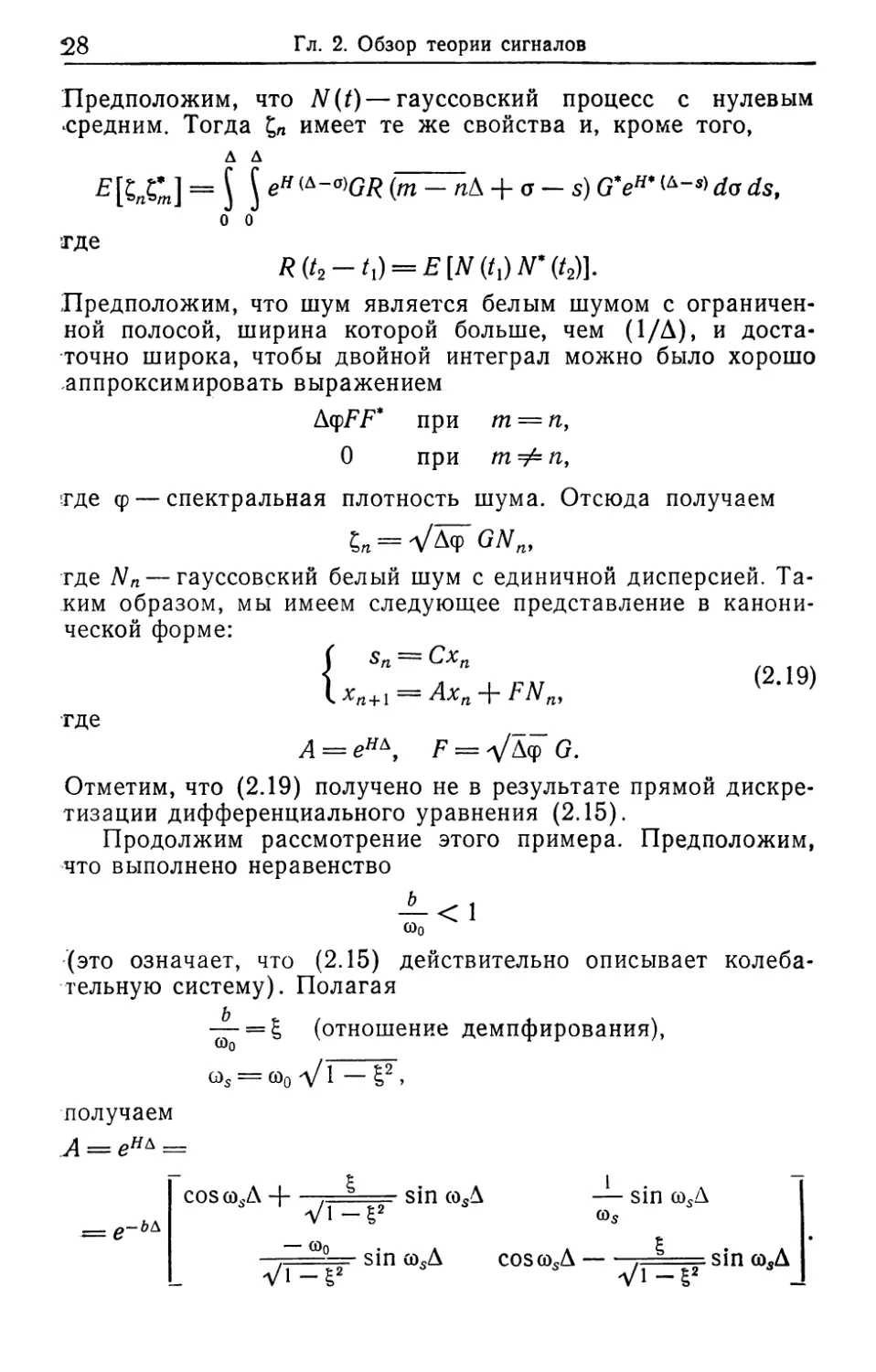

Предположим, что N(t)— гауссовский процесс с нулевым

средним. Тогда имеет те же свойства и, кроме того,

д д

= $ J еН (т^~пЛ + а - $) do ds,

о о

где

R(t2-Q = E{N^N'(t2)}.

Предположим, что шум является белым шумом с ограничен-

ной полосой, ширина которой больше, чем (1/А), и доста-

точно широка, чтобы двойной интеграл можно было хорошо

аппроксимировать выражением

AqpFF* при т = п,

О при т Ф п,

Ф— спектральная плотность шума. Отсюда получаем

£п = УЛф GNn,

где Nn — гауссовский белый шум с единичной дисперсией. Та-

ким образом, мы имеем следующее представление в канони-

ческой форме:

( sn = Схп

1 (2.19)

L %п+1 Nп>

ТДе ____

А = ен\ F = VA<p G.

Отметим, что (2.19) получено не в результате прямой дискре-

тизации дифференциального уравнения (2.15).

Продолжим рассмотрение этого примера. Предположим,

что выполнено неравенство

ь

С00

< 1

(это означает, что (2.15) действительно описывает колеба-

тельную систему). Полагая

— = £ (отношение демпфирования),

COq

= соо V1 — &2 >

получаем

А = ен& =

— t 1

coscosA Н-. - sin cosA — sin cosA

ал V1—E2

-- Q-ЬЬ.

~ <B°— s i n asA cos to.A--, — s i n co. A

Vi-g2 Vi-i2

Задачи

29

Отметим, что система (С ~ 4)-наблюдаема. Из этого сле-

дует, что мы можем получить «разностное уравнение» для sn.

Учитывая тот факт, что

А2 + (2е-ь д cos cosA) А + е~ьЧ = О

(теорема Кэли — Гамильтона [1]), находим

sn+2 + (2е-6Д cos <в5Д) s„+, + е"6Д«„ = (е"6Д —n^A ) Va/?(O)JV„.

Кроме того, если А устойчива, сигнал {sn} является асимпто-

тически стационарным и эргодическим. Его спектральная

плотность имеет вид

Р (X) = С (/ - е2я‘М)-1 FF* (1 - е-2л‘М*)-1 С* =

__А/? (0) е~26д sin2<BsA | -ьд -2л/(A-t-f Д)|-2| -ьл. -2nllK-f Д) |~2

~ <Bq(1 —g2) |в 1 16 1 ’

где 2л/0 = со0, 2rcfs = a)s.

Отметим, что р(Л) достигает максимума при

Z = + fsA ^zb f0A

для малых g. Кроме того,

дД — (2лДЛ) £ |

в предположении, что g мало. Окончательно для logp(X)

имеем

log р (К) = const — log (1 + e~2b^ — 2e~b& cos (A, — fsA)) —

— log (1 + e-26A — 2e-dA cos (X + fsA)),

где второй член является симметричным относительно fsA с

максимумом в fsA, в то время как третий член симметричен

относительно —fsA с максимумом в —/$Д. Чем меньше &, тем

острее пики.

Задачи

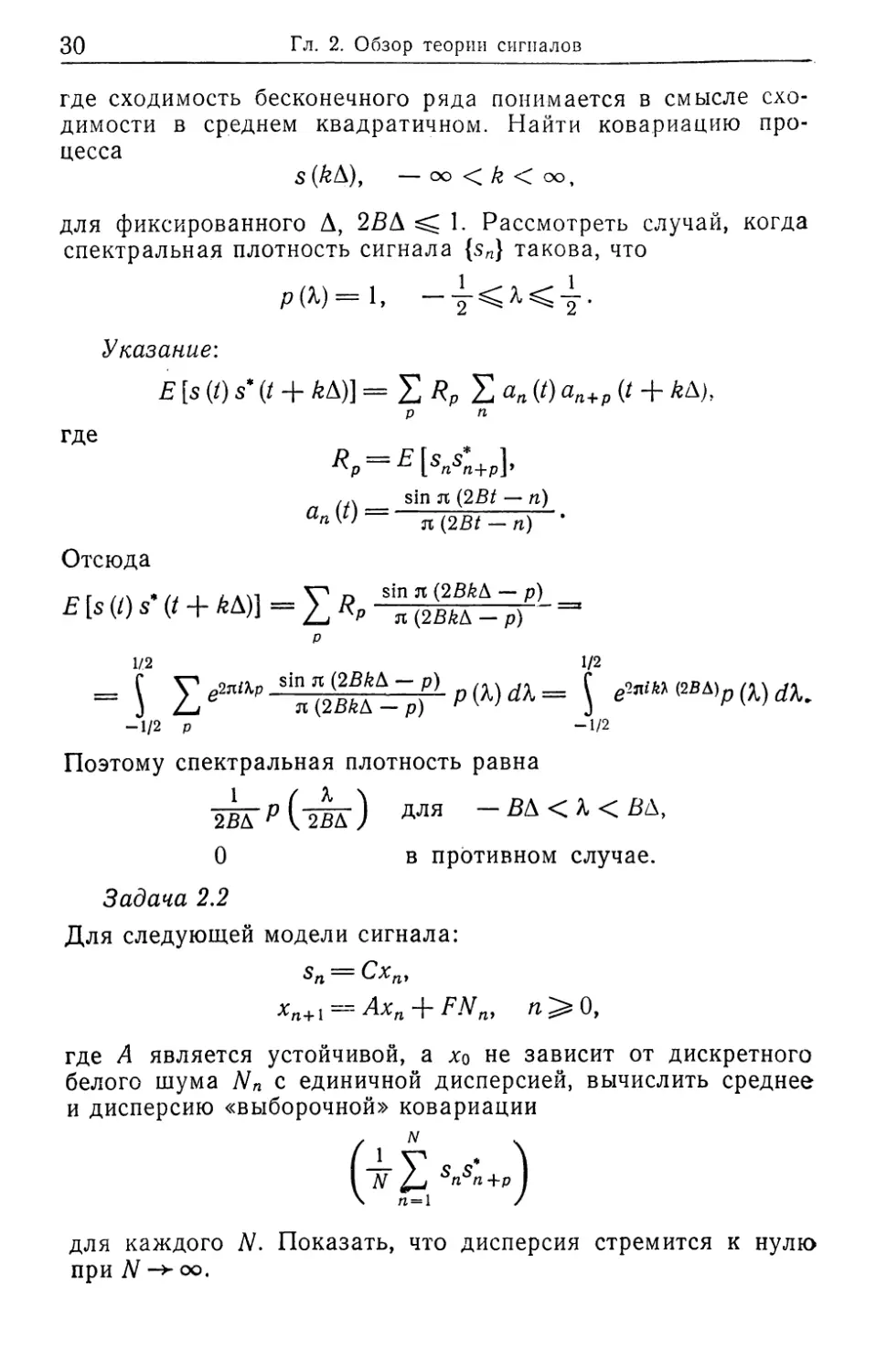

Задача 2,1

Пусть {sn}—стационарный гауссовский сигнал со спектраль-

ной плотностью р(Х). Определим (при фиксированном В)

стохастический процесс с непрерывным временем равенством

с /А _ V с Sin Л <2gZ ~ »)

S W Д sn л (2В/ _ .

30

Гл. 2. Обзор теории сигналов

где сходимость бесконечного ряда понимается в смысле схо-

димости в среднем квадратичном. Найти ковариацию про-

цесса

s(kb), -оо<&< оо,

для фиксированного Д, 2ВД 1. Рассмотреть случай, когда

спектральная плотность сигнала {sn} такова, что

р(Х)=1,

Указание:

Е [$ (/) s’ (/ + АД)] = S RP Е ап (t) ап+р (t + АД),

р п

где

Яр = -Ерп5„+р],

__ sin л ““ п)

~ я (2В/ - п) •

Отсюда

е [»w ? v + ед = £ "" " St;,'0- -

р

1/2 1/2

= j Хе2яар 5я(2В^~р)Р) 5 ^M(2BAWW

-1/2 р -1/2

Поэтому спектральная плотность равна

2ВД” Р ("255") для — В\ < К < Вк,

0 в противном случае.

Задача 2.2

Для следующей модели сигнала:

sn =

xn+{=^Axn + FNnt n^Q,

где А является устойчивой, а х0 не зависит от дискретного

белого шума с единичной дисперсией, вычислить среднее

и дисперсию «выборочной» ковариации

( N \

I N snsn+p I

\ n = l /

для каждого N. Показать, что дисперсия стремится к нулю

при N -> оо.

Задачи

31

Задача 2.3

Доказать неравенство Шварца для случайных векторов х, yt

£•(1 [х, у] |2)<£[||х||2]Е[1И12].

Доказать неравенство Гёльдера

Vf in х+у и < v«+vwm

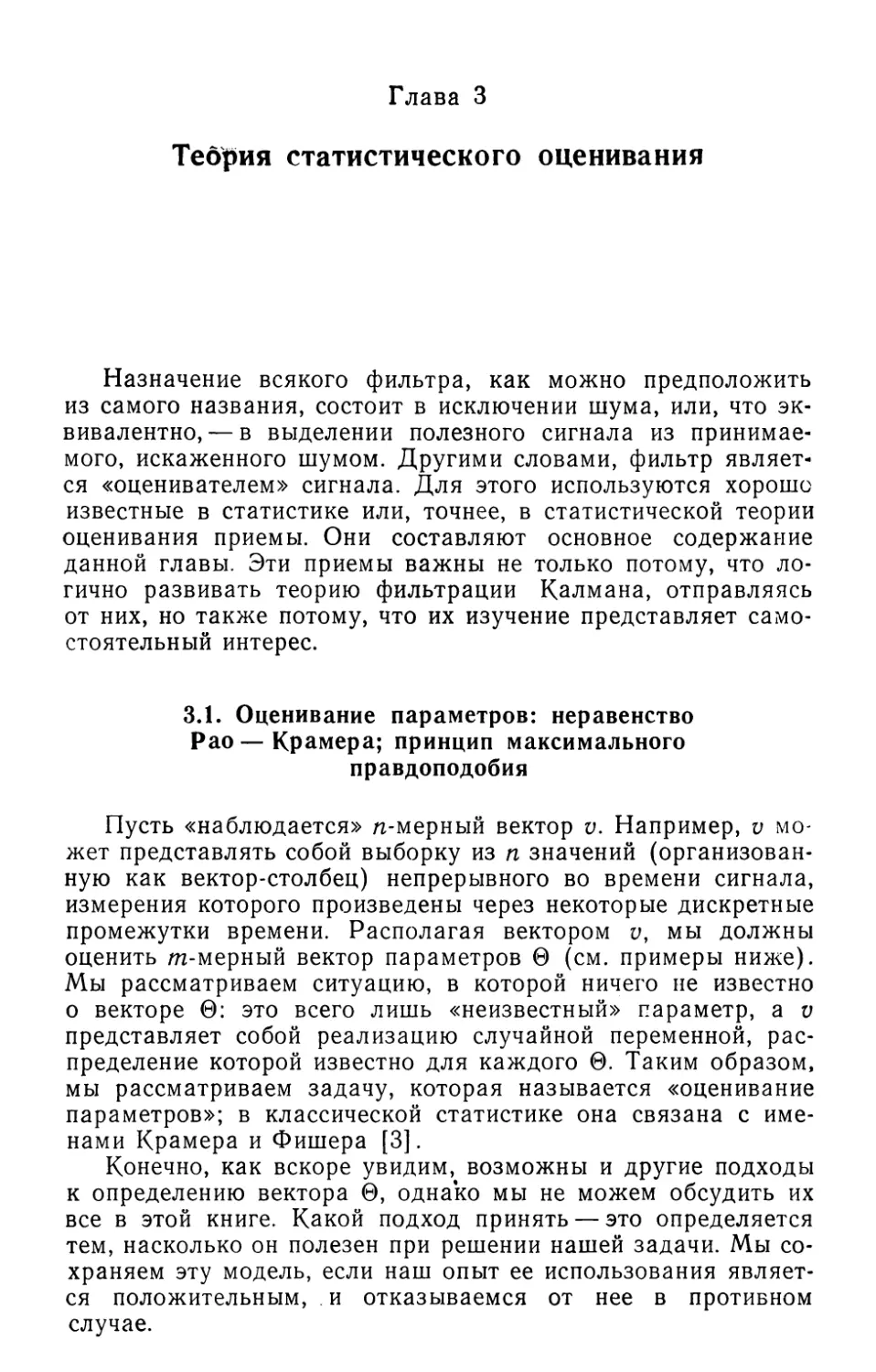

Задача 2.4

Рассмотрим следующий численный пример для системы

(2.16):

со0 = 2б; А ==0.01; & = 0.5со0-

Показать, что

Г 0.9714 0.00881

А “1-5.4723 0.7525]

Проверить, что собственные значения А равны ехр(—6Д zt

it 1(о$Д).

Сравнить ковариации стационарного состояния для моде-

лей с непрерывным и дискретным временем.

Задача 2.5

Пусть в модели (2.15)

v{^~dF

является выходом. Построить соответствующую модель е дис-

кретным временем, аналогичную (2.19).

Задача 2.6

Показать, что рх(Х), определенная выражением (2.13), яв-

ляется невырожденной для каждого X, если система [А ~ F)*

управляема, а А — простая матрица.

Глава 3

Теория статистического оценивания

Назначение всякого фильтра, как можно предположить

из самого названия, состоит в исключении шума, или, что эк-

вивалентно,— в выделении полезного сигнала из принимае-

мого, искаженного шумом. Другими словами, фильтр являет-

ся «оценивателем» сигнала. Для этого используются хорошо

известные в статистике или, точнее, в статистической теории

оценивания приемы. Они составляют основное содержание

данной главы. Эти приемы важны не только потому, что ло-

гично развивать теорию фильтрации Калмана, отправляясь

от них, но также потому, что их изучение представляет само-

стоятельный интерес.

3.1. Оценивание параметров: неравенство

Рао—Крамера; принцип максимального

правдоподобия

Пусть «наблюдается» n-мерный вектор v. Например, v мо-

жет представлять собой выборку из п значений (организован-

ную как вектор-столбец) непрерывного во времени сигнала,

измерения которого произведены через некоторые дискретные

промежутки времени. Располагая вектором v, мы должны

оценить m-мерный вектор параметров 0 (см. примеры ниже).

Мы рассматриваем ситуацию, в которой ничего не известно

о векторе 0: это всего лишь «неизвестный» параметр, a v

представляет собой реализацию случайной переменной, рас-

пределение которой известно для каждого 0. Таким образом,

мы рассматриваем задачу, которая называется «оценивание

параметров»; в классической статистике она связана с име-

нами Крамера и Фишера [3].

Конечно, как вскоре увидим, возможны и другие подходы

к определению вектора 0, однако мы не можем обсудить их

все в этой книге. Какой подход принять — это определяется

тем, насколько он полезен при решении нашей задачи. Мы со-

храняем эту модель, если наш опыт ее использования являет-

ся положительным, и отказываемся от нее в противном

случае.

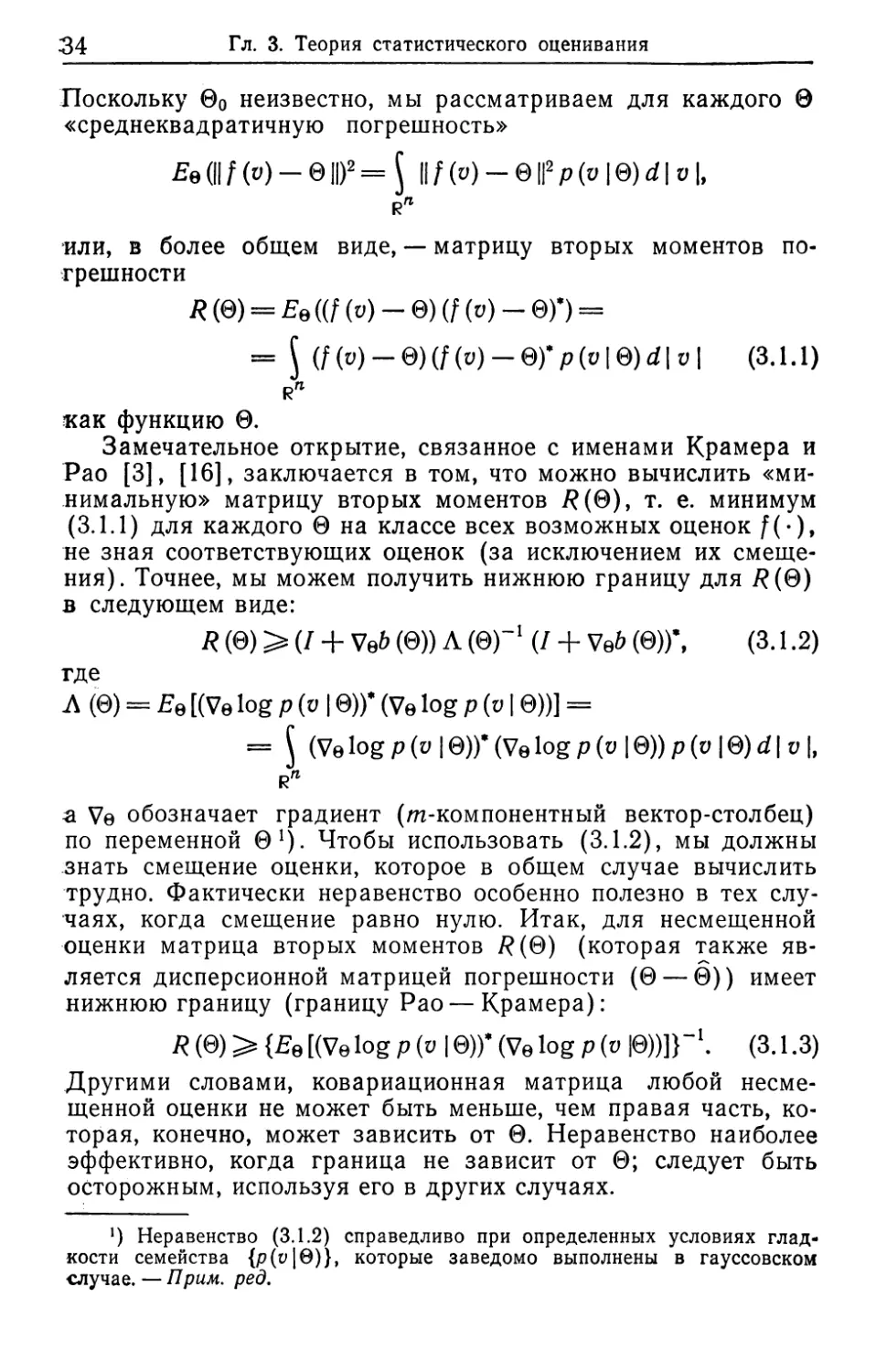

3.1. Оценивание параметров

33

Неизвестным вектором параметров 0 может быть любая

точка в m-мерном евклидовом пространстве, обозначаемом

Rm, и, конечно, v представляет собой точку в R". Для наших

целей в этой книге нам необходимо рассмотреть только слу-

чай, когда распределение v может быть представлено функ-

цией плотности, или, в чисто математических терминах, когда

распределение v абсолютно непрерывно относительно меры

Лебега. Это означает, что мы располагаем семейством (в за-

висимости от параметра 0) плотностей распределения:

р (о 10) О, р (v | 0) d | v | = 1.

Обозначение p(v|0) специально введено для того, чтобы

можно было рассматривать p(v|0) как условную плотность

распределения v при заданном 0, хотя 0 не является случай-

ной величиной.

Любая «оценка» 0 будет (фактически должна быть>

функцией v. Поэтому, обозначая «крышкой» оценку, мы мо-

жем записать

0 = /(у),

где функция f(*) полностью определяет оценку. Как мы бу-

дем измерять качество нашей оценки? Заметим, что f(u) яв-

ляется случайной величиной. Поэтому любая такая мера

должна использовать «статистические средние». Начнем с пер-

вого момента:

£e(0)= J/(v)p(o|0)rf|v|,

где индекс 0 означает, что 0 — фиксированный параметр. Раз-

ность

Ее (0) —- 0

называется «смещением оценки». Ясно, что смещение есть

функция от 0:

6(0) = Ее(0)-0.

Оценка называется «несмещенной», если ее смещение равно-

нулю.

Пусть 0О обозначает «истинное» значение параметра 0Г

которое, конечно, неизвестно и в действительности не может

быть известным. Тем не менее мы можем говорить о «погреш-

ности»

2 Балакришнан А.

/(«) —00-

34

Гл. 3. Теория статистического оценивания

Поскольку ©о неизвестно, мы рассматриваем для каждого 0

«среднеквадратичную погрешность»

(II f (v) - © II)2 = $ II f (у) - © II2 Р (v 10) d | v I,

r"

•или, в более общем виде, — матрицу вторых моментов по-

грешности

R (©) = ((/ (v) - ©) (f (v) - ©)*) =

= J (/(V) — @)(/(v) — ©)*p(v|@)rf| v | (3.1.1)

как функцию 0.

Замечательное открытие, связанное с именами Крамера и

Рао [3], [16], заключается в том, что можно вычислить «ми-

нимальную» матрицу вторых моментов /?(©), т. е. минимум

(3.1.1) для каждого 0 на классе всех возможных оценок /(•),

не зная соответствующих оценок (за исключением их смеще-

ния). Точнее, мы можем получить нижнюю границу для /?(0)

в следующем виде:

R (0) >(/ + Ve6 (©)) Л (0)"1 (/ + VeZ> (©))’, (3.1.2)

где

Л (0) = Eq [(Ve log р (о 10))* (Ve log р (v | 0))] =

= (Velogp(v |0))’(V0logp(t> |0))p(o |0)d| v |,

r"

з Ve обозначает градиент (m-компонентный вектор-столбец)

по переменной 01). Чтобы использовать (3.1.2), мы должны

знать смещение оценки, которое в общем случае вычислить

трудно. Фактически неравенство особенно полезно в тех слу-

чаях, когда смещение равно нулю. Итак, для несмещенной

оценки матрица вторых моментов /?(©) (которая также яв-

ляется дисперсионной матрицей погрешности (0 — 0)) имеет

нижнюю границу (границу Рао — Крамера):

R (0) > {Eq [(V0 log р (v 10))* (Ve log p (v |0))]}-1. (3.1.3)

Другими словами, ковариационная матрица любой несме-

щенной оценки не может быть меньше, чем правая часть, ко-

торая, конечно, может зависить от 0. Неравенство наиболее

эффективно, когда граница не зависит от 0; следует быть

осторожным, используя его в других случаях.

!) Неравенство (3.1.2) справедливо при определенных условиях глад-

кости семейства {р(и|0)}, которые заведомо выполнены в гауссовском

случае. — Прим, ред.

3.1. Оценивание параметров

35

Доказательство формулы для границы Рао — Крамера

Покажем, как доказать (3.1.2). Прежде всего нам необ-

ходимо предположить, что

Ve р (и 10) d | v | = VeP (v 10) d | о |.

r" r"

Или, другими словами, «дифференцирование по параметру 0

допускается под знаком интеграла». Существуют нетриви-

альные случаи, когда это не выполняется (см. [3]), но, к

счастью, нет необходимости рассматривать их в этой книге.

Отметим, в частности, что так как

p(u|0)d| v |— 1,

r"

то

VeP (и 10) d | v | = О,

Rn

или, поскольку

Velogp(o |0) =

1е)

Р (о I в)

(где мы исключаем те значения и, для которых знаменатель

равен нулю), то можно записать эквивалентное равенство:

J (Ve log р (v 10)) р (а | 0) d | v | = 0, (3.1.4>

R"

ИЛИ

(Ve log р (ц 10)) — О

для всех 0 s Rm. Как мы видели, смещение

b (0) = Е [0] — 0 = f (и) р (v 10) d | v | — 0

является функцией 0. Поскольку можно дифференцировать

под знаком интеграла, то

Ve6(0)= $ Vep(v|0)d| v |— I,

где / — единичная матрица размера отХш, и мы можем пе-

реписать это выражение в следующем виде:

/ + ?е&(0) = ф(0), (3.1.5)

где, с учетом (3.1.4), окончательно можно записать

Ф(®)= $ (f(o)-0)(Velogp(u|0))p(u|0)d| у|. (3.1.6)

r"

2*

36 Гл. 3. Теория статистического оценивания

Неравенство Рао — Крамера является в сущности прямым

следствием хорошо известного неравенства Шварца. Чтобы

это увидеть, введем следующие обозначения:

Л = /(и) —0,

В = Ve log р {v |0).

Отметим, что А имеет размер тХ1, а В — размер 1 Х^, так

что размер В* есть т\1. Пусть Л — какая-либо матрица

размера т\т. Напомним, что

((А - АВ*) (А - АВУ) > О,

а поэтому

J (А - АВ*) (А - АВ*)* р (v | 0) d | v | > 0. (3.1.7)

Раскроем в (3.1.7) скобки. Получаем

Ее (АА*) - АЕе (В*А') - В0(АВ) Л* + АВ0 (В’В) Л* > 0. (3.1.8)

Теперь предположим, что (т X w)-матрица

Ее (В*В) = J (Ve log р (v | 0))* (Ve log р (v | 0)) р (v | 0) d | v |

Rn

невырождена для всех 0. Тогда для каждого 0 в (3.1.8) мож-

но выбрать

Л = Ев(АВ)-(Ев(В*В))-1.

После преобразований получаем неравенство

Ее(ЛЛ’) - Ев(АВ) (Ее(В’В))-1 Ее(В'А')^0,

которое без труда преобразуется в неравенство (3.1.2).

Возникает важный вопрос: когда мы можем найти такую

оценку, у которой матрица вторых моментов действительно

достигает минимума? Другими словами, когда в (3.1.2) вы-

полняется равенство? Оценка, для которой в (3.1.2) имеет

место равенство, называется эффективной. Итак, равенство

в (3.1.2) имеет место, если имеет место равенство в (3.1.7),

или

А - АВ* = 0,

т. е. f (•) удовлетворяет равенству

f (v) - 0 = Л (V0 log р (v |0)Г (3.1.9)

(исключая значения v, д.ля которых p(v|0) = O). Но из (3.1.9)

.видно, что

Be (/ (и) — 0) = АЕе (Ve log р (v | 0))* = 0,

3.1. Оценивание параметров

37

т. е. оценка f(v) является несмещенной. Кроме того, матрица

вторых моментов погрешности (которая теперь является так-

же ее дисперсионной матрицей) имеет вид

£е((/(»)-©) (/(»)-©)’) =

= Л£0 [(Ve log р (о 10))* (Ve log р (о 10))] Л*

или

= [Ее ((Ve log р (v 10))’ Ve log р (и 10))]"*. (3.1.10)

Таким образом, для того, чтобы оценка f (v) была эффек-

тивной, Velogp(y|0) должен выражаться в виде

Ve log р (v | ©)* = М (©) (/ (V) - 0) (3.1.11)

для некоторой функции Л1(0) и всех и и 0. Наиболее важным

является случай, когда в (3.1.10) f(v) линейно зависит от и.

В заключение мы приведем другое выражение для вычис-

ления правой части в (3.1.10) (величины, обратная к которой

есть граница Рао — Крамера для несмещенной оценки). Пусть

0 = Col (01, ..., 0m). Тогда

Е [(Ve log р (v 10))* (Ve log p (v | ©))] =

“-{£(т5в71°е'’<,'10>)}- I3-1-12)

Это следует из того, что

°=Ж- (pf’iewi-

Rn

= $^((wlogp(vl0))p(o|0))d,v|=

Rn

= J (-^-logp(o|0)) (-^-logp(p|0))p(o|0)d|v| +

Rn

4- 5 (-asSey loep(» P(f I®)»I-

Принцип максимального правдоподобия

До сих пор мы обсуждали только меру качества оценок,

но не рассмотрели задачу нахождения оценки, которая яв-

ляется оптимальной, т. е., другими словами, минимизирует

матрицу моментов погрешности (для всех 0). К сожалению.

38

Гл. 3. Теория статистического оценивания

не существует систематического метода отыскания оптималь-

ной оценки, даже если такая существует. Не всегда удается

показать, что эффективная оценка существует. Тем не менее

мы выберем один способ нахождения оценок, который имеет

некоторые особенности, позволяющие рекомендовать именно

его, и фактически только он один используется для всех прак-

тических целей. Это принцип максимального правдоподобия.

Оценкой максимального правдоподобия (ОМП для кратко-

сти) является оценка, которая максимизирует р(у|0) отно-

сительно 0 для каждого v. Поскольку в точке максимума

функции (обладающей необходимыми свойствами дифферен-

цируемости) ее градиент должен равняться нулю, то ОМП

удовлетворяет равенству

Velogp(y |0) = О.

Можно указать одно замечательное свойство ОМП: эф-

фективная оценка, если она существует, является оценкой

максимального правдоподобия. Чтобы это увидеть, вернемся

к равенству (3.1.11), которое характеризует эффективную

оценку f(v). Зафиксируем в нем v. Тогда ОМП является та-

кая величина 0, которая обращает левую часть равенства

в нуль. Поскольку Л4(0) невырождена, то мы получаем, что

f(v)_© = 0,

или f(v), т. е. эффективная оценка, является к тому же ОМП.

В общем случае оценка максимального правдоподобия не

обязательно является несмещенной, и к тому же вычисление

соответствующей матрицы ковариаций погрешности также

может быть нетривиальным. К счастью, нас чаще интересует

лишь «асимптотический» случай, когда 0 имеет фиксирован-

ную размерность, в то время как размерность вектора v воз-

растает. Это означает, например, что мы получаем все больше

и больше данных наблюдений. Таким образом, мы можем го-

ворить об оценке, являющейся «асимптотически» несмещен-

ной и «асимптотически» эффективной. Как правило, ОМП

имеет эти замечательные асимптотические свойства, но, ко-

нечно, они требуют доказательства в каждой конкретной за-

даче. Для дальнейшего изучения из статистической литера-

туры рекомендуется [3] и [16].

Задача 3.1.1

Определить класс оценок, которые являются смещенными

и для которых граница Рао — Крамера минимальна, т. е.

правая часть в выражении (3.1.2) равна нулю для любого

p(v|0).

Примеры

39

Указание: положить

Veft(0) + Z = O.

Примеры

Пример 3.1.1

Наш первый пример является, возможно, наиболее ста-

рым из примеров такого рода. Пусть

Р (v I = (^‘i ^p/2 ехР { ~ Т[Я"’ (о - L&), (.v - £0)]},

где матрица L имеет размер п\т. Это означает, что v —

гауссовский случайный вектор со средним L0 и дисперсион-

ной матрицей R. Очень просто проверить, что

(Velog р (v |©))* = L*R~l (v - LQ).

Предположим, что равенство L® = 0 влечет за собой 0 = 0,

или, что эквивалентно, L*L невырождена. Тогда матрица

Е [(Ve log р (о 10))* (Ve log р (о 10))] =

= £ [Г/?-1 (и - £0) (v - £0)’ £-1L] =

= L'R-'L

также является невырожденной. Таким образом, матрица

границы Рао — Крамера имеет вид

(L'R-'L)-1,

и граница не зависит от 0. Оценка максимального правдопо-

добия задается выражением

LR~l (о —£0) = О,

или

q = (l:r-'l)-1l*r-1v.

Эта оценка является несмещенной, поскольку

£ [0] = (£>-1£)-1 L*R~XE [о] = 0.

Оценка является эффективной, поскольку

(Cr-'L)-' LR~lv — @ =

= (£>-1£)-1 L’R-1 [о - £0] =

= (CR-'L)-1 (Velogp(o |0))‘.

40

Гл. 3. Теория статистического оценивания

Пример 3.1.2

Наш второй пример является одним из немногих случаев,

когда эффективная оценка может быть вычислена в явном

виде и является нелинейной. Он также иллюстрирует тот

факт, что даже эффективная оценка может не вполне нас

удовлетворять. Так, пусть

v = aS + Af,

где S и N — независимые гауссовские величины с нулевым

средним и единичными ковариационными матрицами. Нам

нужно оценить а2 (что соответствует энергии сигнала). Ясно,

что

р (v | а2) = , 1 —

V(l + a2)rt

Поэтому

-^-logp(o|a2) =

1 ( 1 [э, и]

(V2ST еХр1 2 1 + а2

п 1 . 1 [о, и]

2 1 + а2 2 (1 + а2)2 *

Таким образом, оценка максимального правдоподобия удов-

летворяет соотношению

Отсюда

п , 1 [и, и] _ 0

2 2 1+9

Эта оценка является эффективной, поскольку

[и, 1 Л2_ 2(1 +a2)2 z п 1 , 1 [о, о] \

п п к 2 1+ а2 Т 2 (1+ а2)2)

В частности, погрешность

Е [(9 - а2)2] = 2(1

Тем не менее эта оценка, хотя она и эффективная, имеет тот

недостаток, что существует ненулевая вероятность события

а2 < 0,

что нежелательно, поскольку мы оцениваем положительную

величину. Мы можем определить новую оценку, которая сво-

бодна от этого дефекта, взяв, например, в качестве оценки

П (tQ + lfo (и)|

2

Эта оценка является смещенной, но имеет меньшую средне-

квадратичную погрешность!

Примеры

41

Пример 3.1.3

Наш третий пример — нелинейный вариант примера 3.1.1,

в котором мы допускаем нелинейную зависимость от неиз-

вестного параметра.

Итак,

Р (V I 0) = №)п|/?|,/-2- ехр { - 4- [Я-1 (V - А (©)), (V-L (0))]} ,

где £(•) отображает R"1 в Rn. Мы полагаем отображение

настолько гладким, что существуют частные производные лю-

бого порядка. В частности, мы имеем разложение по скаляр-

ному параметру X для любого h е Rm:

L(0 + U) = L(0) + W (0)/г +[tf (0) Л, h] +

+ члены более высокого порядка по X,

где функции G (0), Н (0) являются гладкими функциями 0.

Отметим, что G (0) — градиент (n X т-матрица):

G(0) = VeL (0).

В частности, возможно дифференцирование плотности под

знаком интеграла (см. с. 30), и поэтому

(Velog р(v 10))* = G* (0) R~l (v — L(0)),

а значит, для минимальной матрицы Рао — Крамера имеем

выражение

£ [(Ve log р (о 10))’ (Ve log р (v 10))] ==

= £[G* (0) R"1 (v — L (0)) (о - L (0))’ R~'G (0)] =

= G* (0)/?-iG(0).

Таким образом, минимальная матрица Рао — Крамера зави-

сит от 0. Конечно, вопрос о том, существует ли несмещенная

оценка, является спорным. Поэтому в большинстве приложе-

ний мы, так сказать, «жульничаем», или, точнее, «локали-

зуем» задачу. Другими словами, мы предполагаем, что имеем

известную «номинальную» величину (скажем, 0О) и затем

фактически ищем возмущения относительно этой величины.

Строго говоря, мы предполагаем, что

L (0) = Л (0О) + G (0О) (0 —0О).

Определив

V = v — L (0О),

42

Гл. 3. Теория статистического оценивания

возвращаемся к примеру 3.1.1, где матрица L определена ра-

венством L==G(0o). Затем мы можем изучать границу

Рао — Крамера как функцию номинального значения 0О-

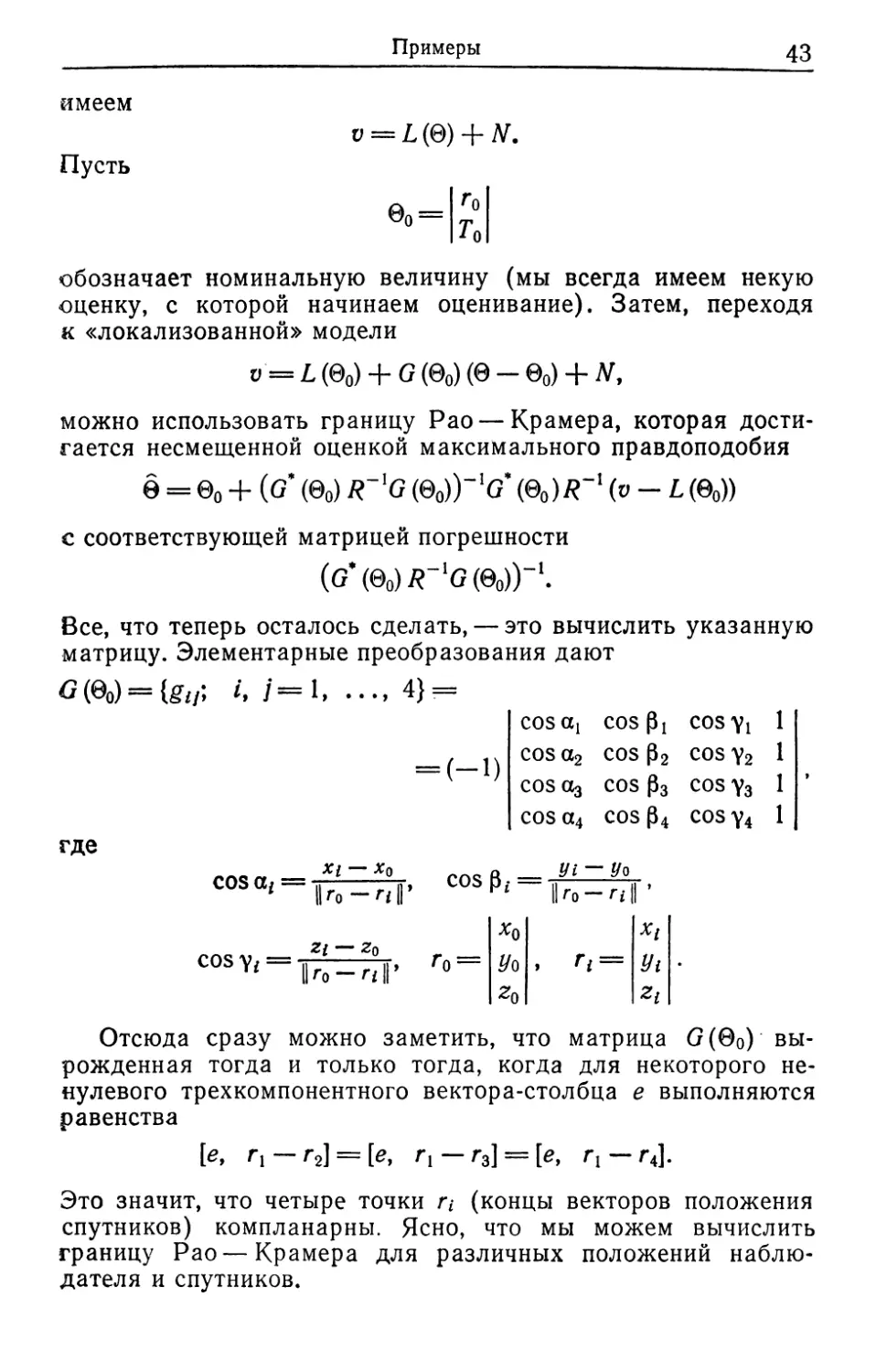

Приложение в навигации

Укажем на одно специальное приложение предыдущих

рассуждений, которое иллюстрирует ранее изложенные

идеи, — решение навигационной задачи с использованием

спутниковой системы глобального ориентирования (Global

Positioning System Satellite Constellation). Более детальное

изложение вопроса приведено в [21, т. II]. Пусть г обозна-

чает трехмерный вектор положения наблюдателя (обычно из-

меряется в ортогональной системе координат относительно-

центра Земли). Пусть п, i= 1, ..., 4, обозначает вектор из-

вестного положения каждого из четырех спутников. Наблю-

датель измеряет запаздывание т/ момента поступления сиг-

нала от каждого из спутников. Это измерение содержит по-

грешность, которую мы будем считать гауссовской случайной

величиной со средним Т («смещение» синхронизации). Тогда<

мы имеем:

Цг-ПН = С(т/ + ^), /=1, 4,

Е&] = Т,

и С — известная скорость света, которую мы для удобства

примем равной 1 (путем соответствующего масштабирова-

ния). Мы хотим оценить вектор г. В самом грубом приближе-

нии нам нужно решить систему

lk-rz|| = Tf + T, Z = 1, 4,

которая состоит из четырех уравнений для четырех неизвест-

ных: три компоненты вектора г и Т. Но нам необходимо из-

мерить, насколько хорошим является решение. Для этой цели

воспользуемся нашей теорией, рассматривая данную задачу

как задачу оценивания параметров. Тогда в обозначениях

Примеры

43

имеем

Пусть

v = L(Q) + N.

©о =

Го

TQ

обозначает номинальную величину (мы всегда имеем некую

оценку, с которой начинаем оценивание). Затем, переходя

к «локализованной» модели

y = L(0o) + G(0o)(0-0o) + Af,

можно использовать границу Рао — Крамера, которая дости-

гается несмещенной оценкой максимального правдоподобия

ё = 00 + (G* (0о) R~'G (©o))~’G* (<W* (v-L (0o))

с соответствующей матрицей погрешности

(g\&0)r-1g(q0)Y1.

Все, что теперь осталось сделать, — это вычислить указанную

матрицу. Элементарные преобразования дают

G(0o) = U//; i, j=l> .... 4}-

coscq COS Pi COSY! 1

__._cosa2 cos p2 cos y2 1

' COS Оз COS 03 COS Уз 1

cos a4 cos 04 cos y4 1

где

cosa^i^, cosp^^j-,

2/ Zq

ko — ri ||’

cos yz

k

yt

Zl

Отсюда сразу можно заметить, что матрица G(0O) вы-

рожденная тогда и только тогда, когда для некоторого не-

нулевого трехкомпонентного вектора-столбца е выполняются

равенства

[е, Г1 —г2] = [е, И —г3] = [е, г,— г4].

Это значит, что четыре точки г/ (концы векторов положения

спутников) компланарны. Ясно, что мы можем вычислить

границу Рао — Крамера для различных положений наблю-

дателя и спутников.

44

Гл. 3. Теория статистического оценивания

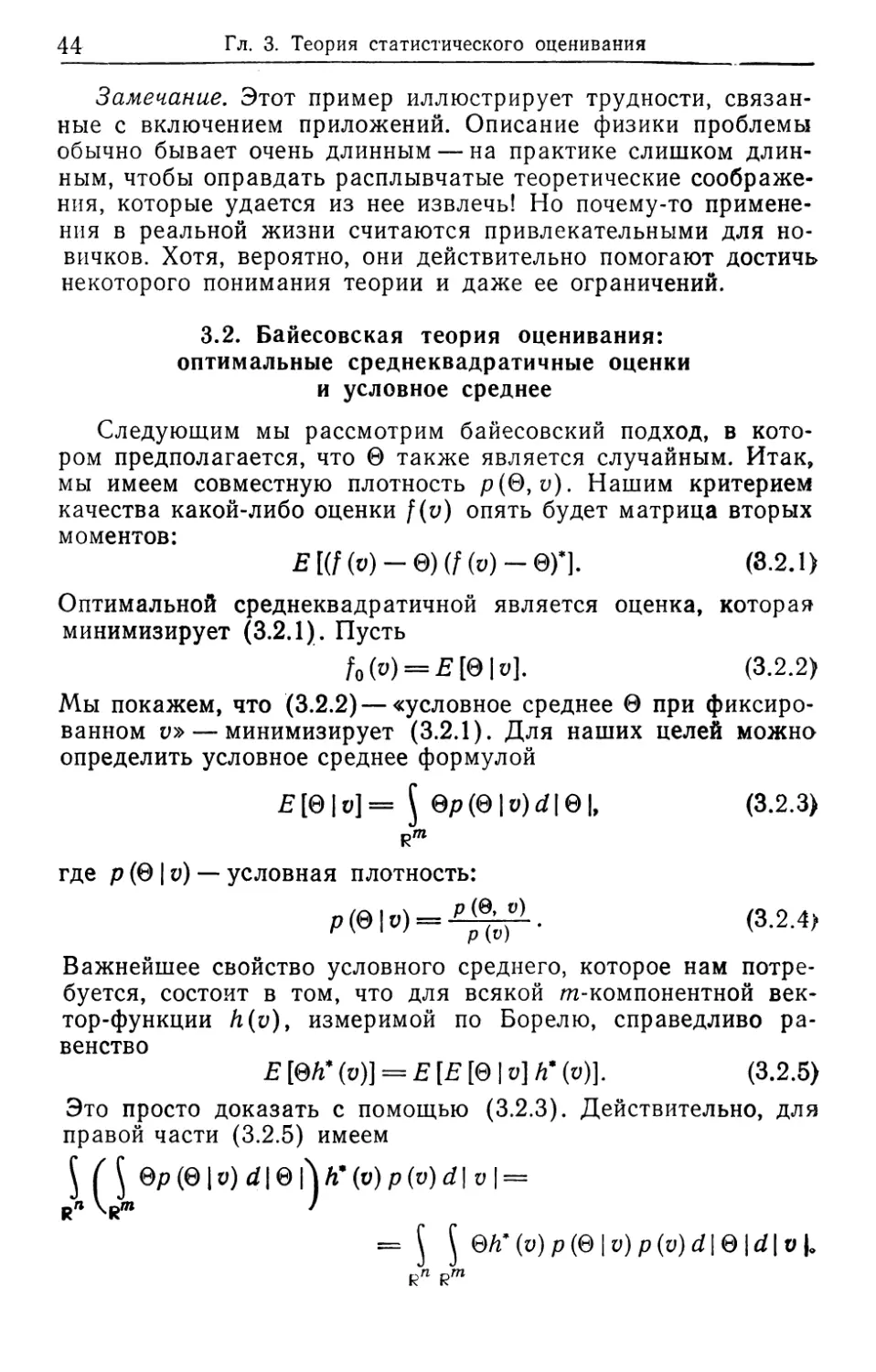

Замечание. Этот пример иллюстрирует трудности, связан-

ные с включением приложений. Описание физики проблемы

обычно бывает очень длинным — на практике слишком длин-

ным, чтобы оправдать расплывчатые теоретические соображе-

ния, которые удается из нее извлечь! Но почему-то примене-

ния в реальной жизни считаются привлекательными для но-

вичков. Хотя, вероятно, они действительно помогают достичь

некоторого понимания теории и даже ее ограничений.

3.2. Байесовская теория оценивания:

оптимальные среднеквадратичные оценки

и условное среднее

Следующим мы рассмотрим байесовский подход, в кото-

ром предполагается, что 0 также является случайным. Итак,

мы имеем совместную плотность р(0, и). Нашим критерием

качества какой-либо оценки f(v) опять будет матрица вторых

моментов:

£[(f(v)-0)(f(v)-в)*]. (8.2.1)

Оптимальной среднеквадратичной является оценка, которая

минимизирует (3.2.1). Пусть

fo(o) = £[0|v]. (3.2.2)

Мы покажем, что (3.2.2) — «условное среднее 0 при фиксиро-

ванном V» — минимизирует (3.2.1). Для наших целей можно

определить условное среднее формулой

£[0|»] = J 0р(0|v)d|01, (3.2.3)

где р (0 | о) — условная плотность:

= (3-2.4)

Важнейшее свойство условного среднего, которое нам потре-

буется, состоит в том, что для всякой m-компонентной век-

тор-функции Л (и), измеримой по Борелю, справедливо ра-

венство

Е [0Л* (и)] = Е [Е [0 | и] й* (о)]. (3.2.5)

Это просто доказать с помощью (3.2.3). Действительно, для

правой части (3.2.5) имеем

М 0р (0 | a) d | 0 й* (о) р (v) d | v | =

= J J @h*(v)p(@\v)p(v)d\Q |rf| v U

3.2. Байесовская теория оценивания

45

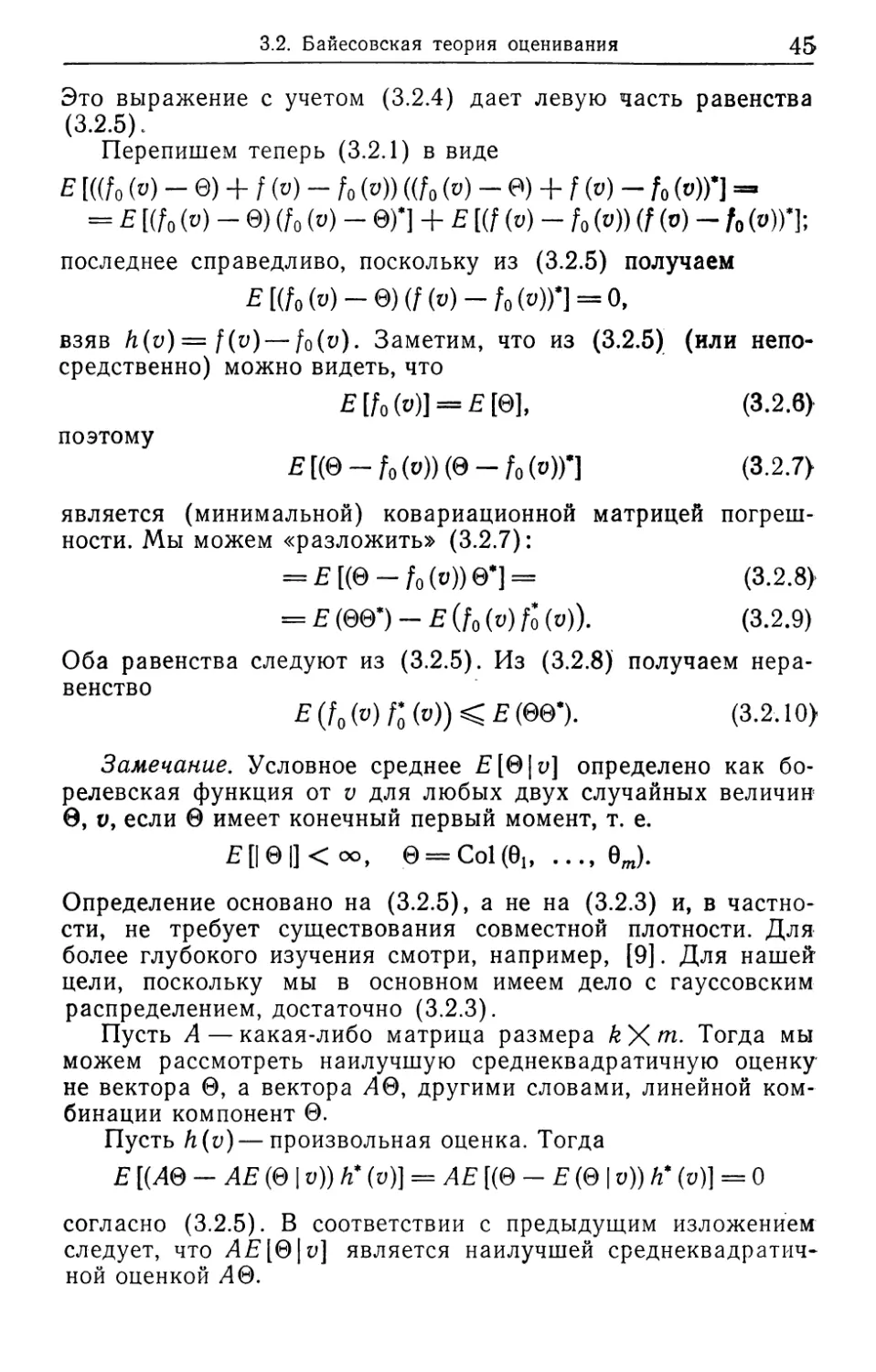

Это выражение с учетом (3.2.4) дает левую часть равенства

(3.2.5).

Перепишем теперь (3.2.1) в виде

Е [((fo (v) - 0) + / (») - fo (»)) «/о (о) - Р) + f (v) - /о (»))*] =

= Е [(/о (v) - 0) (Zo (v) - 0)1 + Е [(f (v) - f0 (v)) (f (о) - /о («))1;

последнее справедливо, поскольку из (3.2.5) получаем

Е [(/о (») - 0) (f (V) - f0 (v))1 = О,

взяв h(v) = f(v)— fo(v). Заметим, что из (3.2.5) (или непо-

средственно) можно видеть, что

E[fo(v)] = £[0], (3.2.6}

поэтому

(3.2.7}

является (минимальной) ковариационной матрицей погреш-

ности. Мы можем «разложить» (3.2.7):

= £[(©- /о (о))0*]= (3.2.8}

= £(00l-£(fo(w)/o(v)). (3.2.9)

Оба равенства следуют из (3.2.5). Из (3.2.8) получаем нера-

венство

E(f0(v)rQ(v))^E(&&r (3.2.10}

Замечание. Условное среднее Е [01 у] определено как бо-

релевская функция от v для любых двух случайных величин

0, v, если 0 имеет конечный первый момент, т. е.

£[|0|]<оо, 0 = Со1(0ь 0J.

Определение основано на (3.2.5), а не на (3.2.3) и, в частно-

сти, не требует существования совместной плотности. Для

более глубокого изучения смотри, например, [9]. Для нашей

цели, поскольку мы в основном имеем дело с гауссовским

распределением, достаточно (3.2.3).

Пусть А— какая-либо матрица размера k\m. Тогда мы

можем рассмотреть наилучшую среднеквадратичную оценку

не вектора 0, а вектора 40, другими словами, линейной ком-

бинации компонент 0.

Пусть h(v)—произвольная оценка. Тогда

Е [(40 - АЕ (0 | и)) й* (у)] = АЕ [(0 - Е (0 | v)) й* (у)] = 0

согласно (3.2.5). В соответствии с предыдущим изложением

следует, что АЕ [0| у] является наилучшей среднеквадратич-

ной оценкой 40.

46

Гл. 3. Теория статистического оценивания

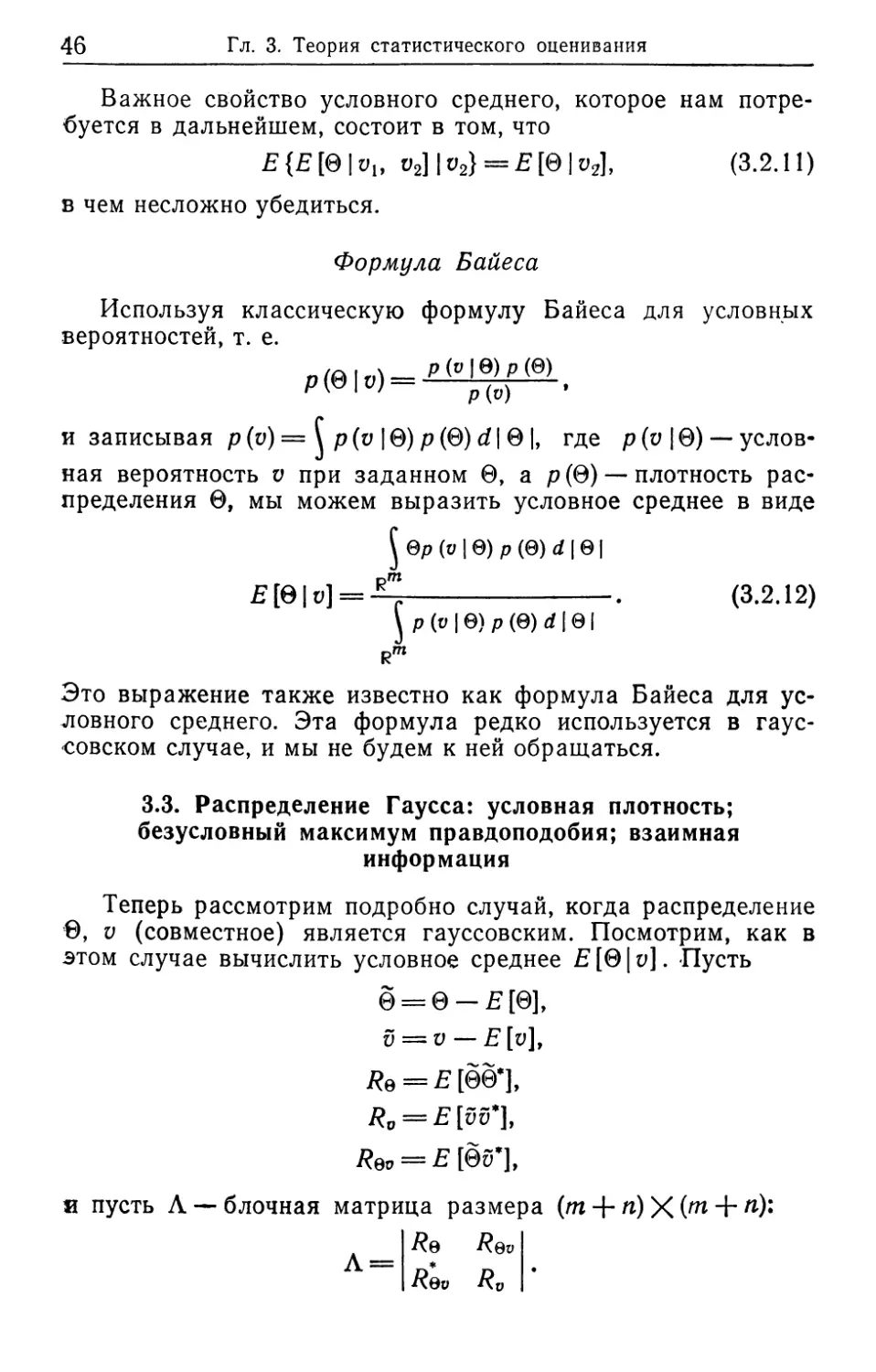

Важное свойство условного среднего, которое нам потре-

буется в дальнейшем, состоит в том, что

E{E[Q\v{, ^]|v2} = £[0|^], (3.2.11)

в чем несложно убедиться.

Формула Байеса

Используя классическую формулу Байеса для условных

вероятностей, т. е.

и записывая р (v) = р (v | 0) р (0) d | 0 |, где р (v 10) — услов-

ная вероятность v при заданном 0, а р (0) — плотность рас-

пределения 0, мы можем выразить условное среднее в виде

0р (и 10) р (0) d 101

Е [© | v] = . (3.2.12)

p(v|0)p(0)d|0|

Rm

Это выражение также известно как формула Байеса для ус-

ловного среднего. Эта формула редко используется в гаус-

совском случае, и мы не будем к ней обращаться.

3.3. Распределение Гаусса: условная плотность;

безусловный максимум правдоподобия; взаимная

информация

Теперь рассмотрим подробно случай, когда распределение

©, v (совместное) является гауссовским. Посмотрим, как в

этом случае вычислить условное среднее Е [01 v]. -Пусть

0 = 0 — £[0],

v = v — £[у],

7?е = £[00*],

R0 = E[vv*],

Rev = Е [0иж],

я пусть Л — блочная матрица размера (m + n)X(m + Л):

Re Rev

Л== R&v R„ •

3.3. Распределение Гаусса

47

Тогда, предполагая, что Л невырождена, и представляя

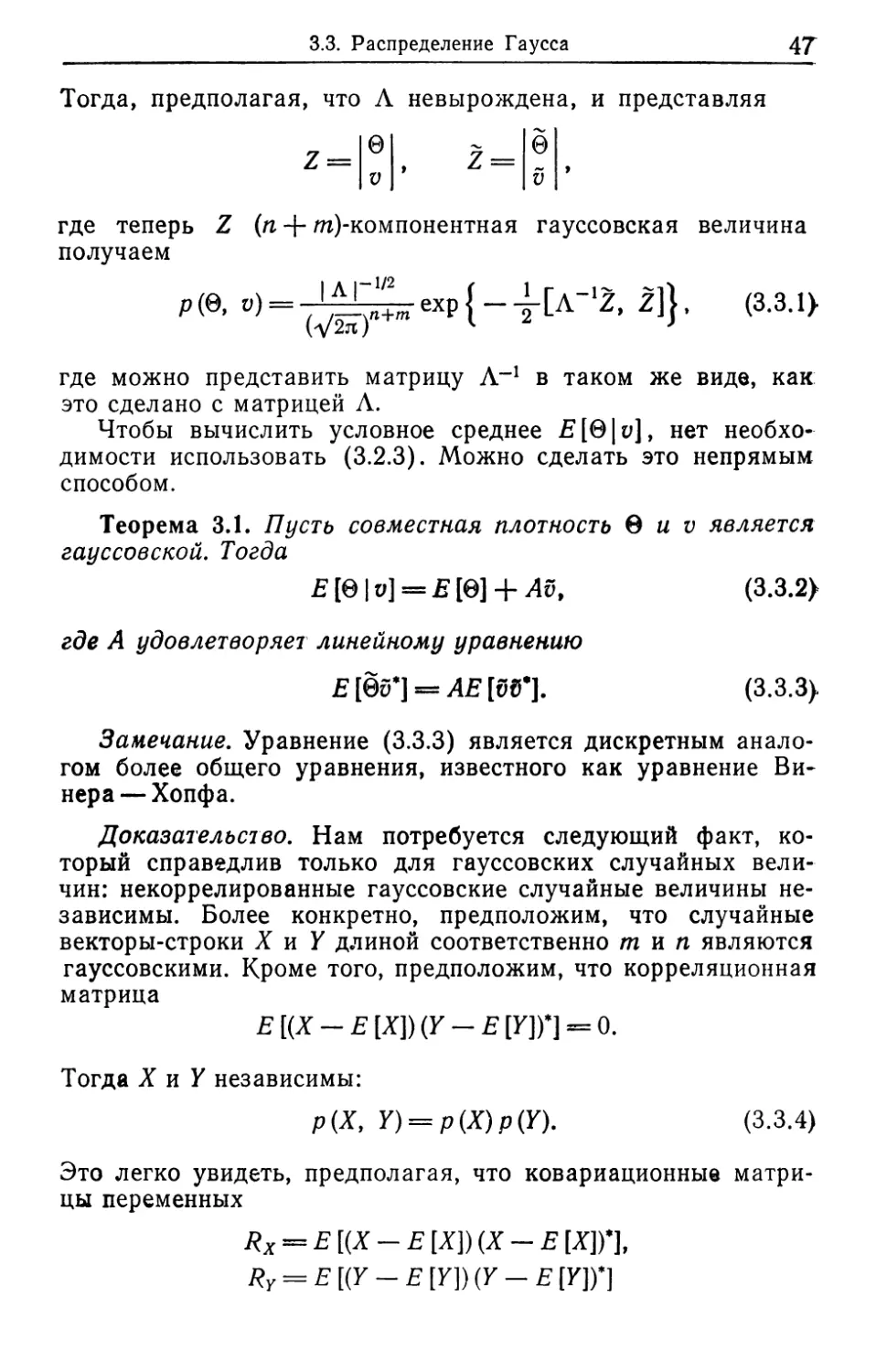

где теперь Z (п + /покомпонентная гауссовская величина

получаем

р(е’ °)= tvsr ехр{-т[Л~'г' <331>

где можно представить матрицу А-1 в таком же виде, как

это сделано с матрицей Л.

Чтобы вычислить условное среднее Е [01 и], нет необхо-

димости использовать (3.2.3). Можно сделать это непрямым

способом.

Теорема 3.1. Пусть совместная плотность Q и v является

гауссовской. Тогда

£[0|и] = £[0] + Av. (3.3.2}

где А удовлетворяет линейному уравнению

Е[0й*] = А£[бГ]. (3.3.3}

Замечание. Уравнение (3.3.3) является дискретным анало-

гом более общего уравнения, известного как уравнение Ви-

нера— Хопфа.

Доказательство. Нам потребуется следующий факт, ко-

торый справедлив только для гауссовских случайных вели-

чин: некоррелированные гауссовские случайные величины не-

зависимы. Более конкретно, предположим, что случайные

векторы-строки X и У длиной соответственно тип являются

гауссовскими. Кроме того, предположим, что корреляционная

матрица

Е[(Х-£[Х])(У-£[У])’] = 0.

Тогда X и У независимы:

р(Х, У) = р(Х)р(У). (3.3.4)

Это легко увидеть, предполагая, что ковариационные матри-

цы переменных

Rx == Е [(X - Е [X]) (X - Е [X])’],

Ry = Е [(У - Е [У]) (У - Е [У])*]

48

Гл. 3. Теория статистического оценивания

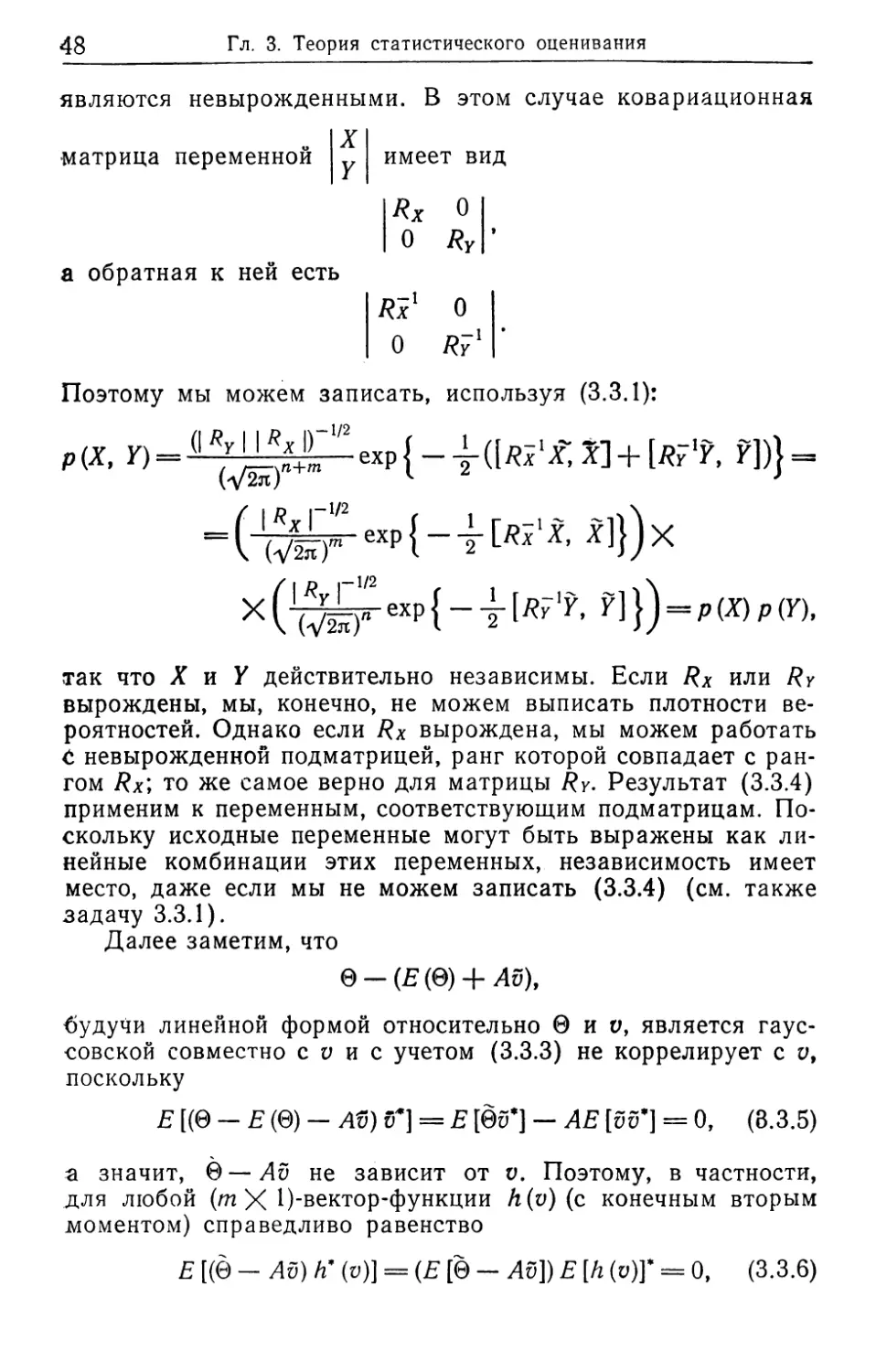

являются невырожденными. В этом случае ковариационная

X

Y

матрица переменной

имеет вид

Rx О

о RY

а обратная к ней есть

Rx' О

О Ry'

Поэтому мы можем записать, используя (3.3.1):

р(Х, Y) = 1 exp{-±X] + [flF'r, ?])} =

= (' (-Mr ехр { “ т [Ях1X, х]})х

x(^L^exp{-4-[/?F'r, У]}) = Р(*)Р(П.

так что X и У действительно независимы. Если Rx или Ry

вырождены, мы, конечно, не можем выписать плотности ве-

роятностей. Однако если Rx вырождена, мы можем работать

С невырожденной подматрицей, ранг которой совпадает с ран-

гом Rx', то же самое верно для матрицы Ry. Результат (3.3.4)

применим к переменным, соответствующим подматрицам. По-

скольку исходные переменные могут быть выражены как ли-

нейные комбинации этих переменных, независимость имеет

место, даже если мы не можем записать (3.3.4) (см. также

задачу 3.3.1).

Далее заметим, что

©-(£(©) + Av),

будучи линейной формой относительно 0 и о, является гаус-

совской совместно с v и с учетом (3.3.3) не коррелирует с v,

поскольку

Е [(0 - Е (0) - AS) v} = Е [0S*] — АЕ [S5*] = 0, (8.3.5)

а значит, 0—Av не зависит от v. Поэтому, в частности,

для любой (m X 1)-вектор-функции h (v) (с конечным вторым

моментом) справедливо равенство

Е [(0 - Av) /г’ (у)] = (£[©- AS]) Е [h (у)]* = 0, (3.3.6)

3.3. Распределение Гаусса

49

эквивалентное равенству

Е [(0 - (£ [О] + A (v - Е М))) /Г (о)] = 0.

Теперь из определения (3.2.5) для условного среднего сле-

дует утверждение нашей теоремы.

Замечание. Гауссовский случай характеризуется тем, что

наилучшая среднеквадратичная оценка линейна относительно

v и остаточный член не зависит от данных.

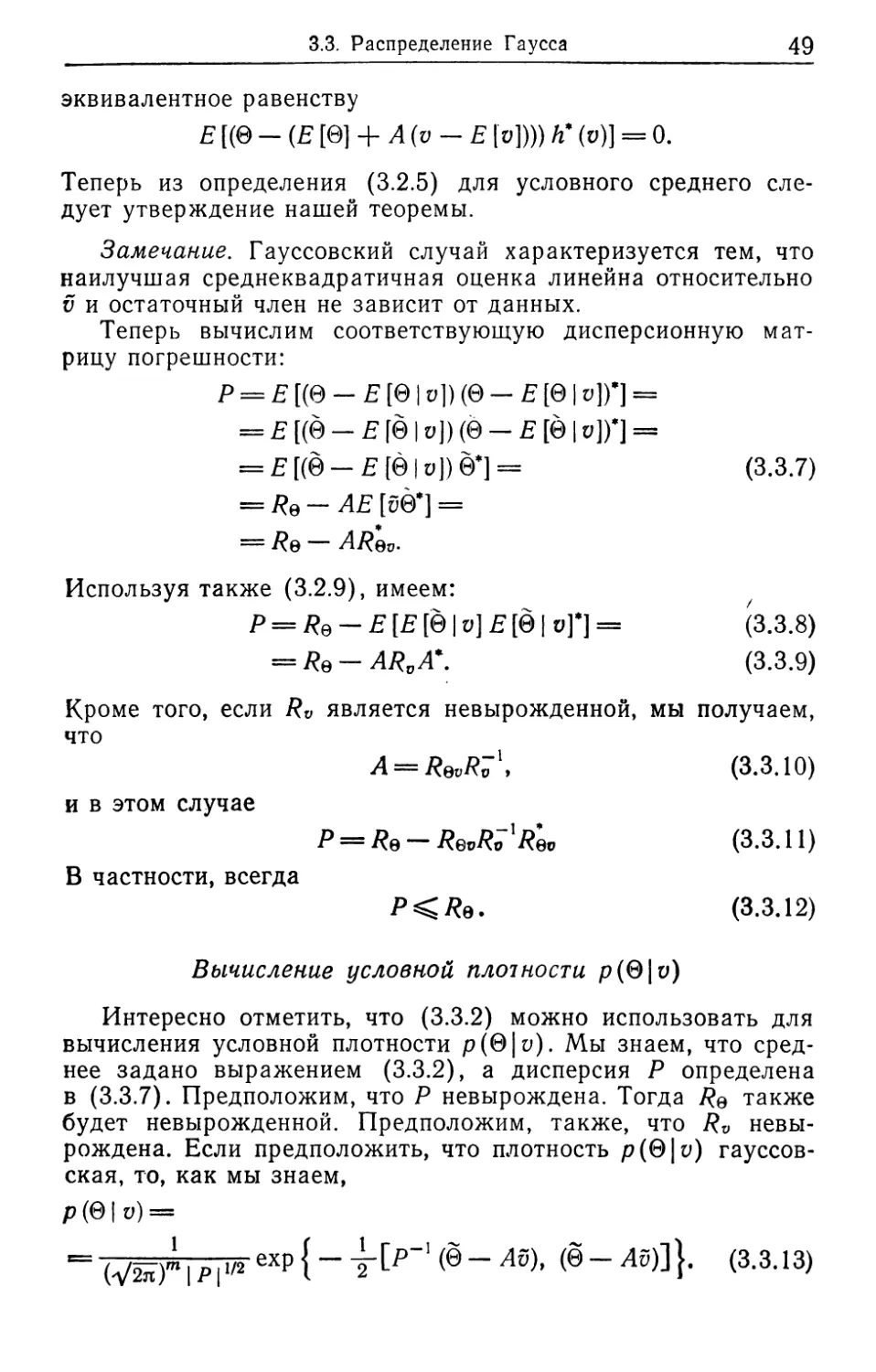

Теперь вычислим соответствующую дисперсионную мат-

рицу погрешности:

р = Е [(© - Е [01 ц]) (0 - Е [0 | ц])*] =

= Е [(0 - Е [0 | v]) (0 - Е [0 | v])*] =

= Е [(0 - Е [01 о]) 0*] = (3.3.7)

= /?0-Л£[50*] =

= — AR®?.

Используя также (3.2.9), имеем:

Р = /?0 - Е [Е [01 v] Е [01 и]*] = (3.3.8)

= Rq — ARvA\ (3.3.9)

Кроме того, если Rv является невырожденной, мы получаем,

что

Д = ^0о/?71. (3.3.10)

и в этом случае

Р = /?в-7?ео2?о->ео (3.3.11)

В частности, всегда

(3.3.12)

Вычисление условной плотности р(0| и)

Интересно отметить, что (3.3.2) можно использовать для

вычисления условной плотности р(0|4- Мы знаем, что сред-

нее задано выражением (3.3.2), а дисперсия Р определена

в (3.3.7). Предположим, что Р невырождена. Тогда 7?0 также

будет невырожденной. Предположим, также, что Rv невы-

рождена. Если предположить, что плотность р(0| v) гауссов-

ская, то, как мы знаем,

р (0 | U) =

= (У2л )m I Р11/2 еХР { 2”^ Av)’ (® ^)]}« (3.3.13)

50

Гл. 3. Теория статистического оценивания

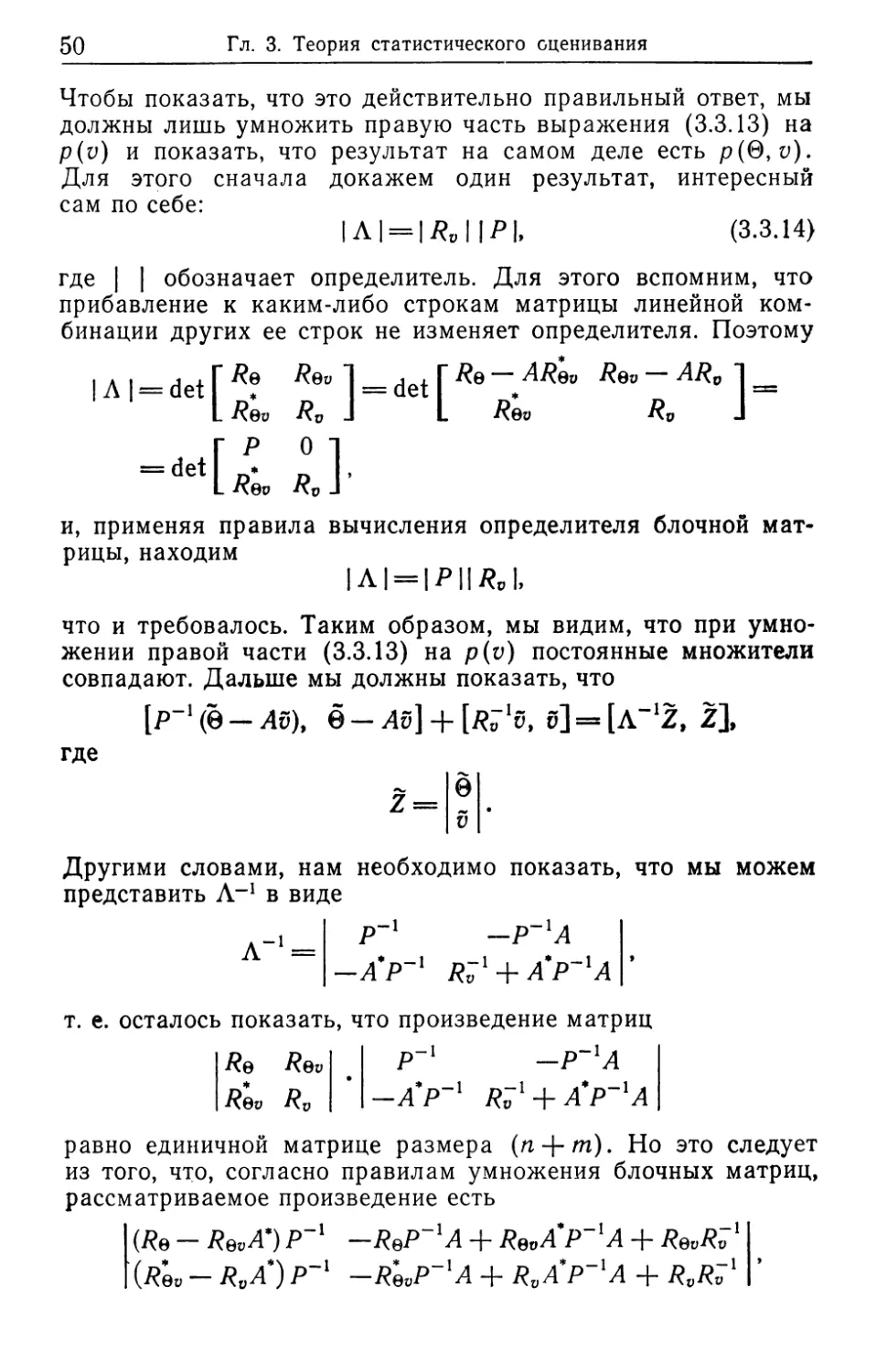

Чтобы показать, что это действительно правильный ответ, мы

должны лишь умножить правую часть выражения (3.3.13) на

p(v) и показать, что результат на самом деле есть р(0, v).

Для этого сначала докажем один результат, интересный

сам по себе:

I Л | = | Rv | |Р|, (3.3.14)

где | | обозначает определитель. Для этого вспомним, что

прибавление к каким-либо строкам матрицы линейной ком-

бинации других ее строк не изменяет определителя. Поэтому

Rqv ___jet Г ARev Rqv

Rv - L Rev Rv

и, применяя правила вычисления определителя блочной мат-

рицы, находим

|Л| = |Р||/?С |,

что и требовалось. Таким образом, мы видим, что при умно-

жении правой части (3.3.13) на p(v) постоянные множители

совпадают. Дальше мы должны показать, что

[p-1(0-4s), ё-лб] + [/г7*б, б]=[л-12, 2],

где

0

v

Z =

Другими словами, нам необходимо показать, что мы можем

представить Л-1 в виде

Л-1= Р~1 ~Р~гА

~ -A'p~l R;1 + A*P~iA

т. е. осталось показать, что произведение матриц

Re Rev . Р~' -Р~'А

Rev Rv ' -А'Р~Х RvX + A'P~'A

равно единичной матрице размера (п-|-/п). Но это следует

из того, что, согласно правилам умножения блочных матриц,

рассматриваемое произведение есть

(Re - RevA’) Р~' -ReP~lA + Re0A'P~lА + RevRv'

(Rev-R0A*)P~l -RevP~'A +RvA'P~lA +RvPv1

3.3. Распределение Гаусса

51

и мы получаем необходимый результат, поскольку матрица Р

•самосопряженная:

Р = ^^00 = ^0 ^0V^ ~ W = О»

-ReP~'A + RevA'P~l А = (~Re + Rv Л*) Р~1А = —А

И

RqvRv == Л.

Замечание. Формула (3.3.14) мало что говорит о Р, по-

скольку в нее входит только определитель. Тем не менее, если

О — скаляр, то Р = | Р |. Таким образом, мы имеем:

Дисперсия погрешности = J , (3.3.14а)

I Kv I

•и, конечно, v может быть произвольной размерности. Отме-

тим, что | Rv | в таком случае является алгебраическим до-

полнением элемента, стоящего в верхнем левом углу, по-

скольку мы можем записать

Л = ае ле»

Aev Rv ’

где

ае = £[00‘],

Ле» =£'[06*],

и имеет размер 1 X т-

Безусловный максимум правдоподобия

Теперь мы укажем другой путь получения (3.3.2) — с ис-

пользованием принципа безусловного максимума правдопо-

добия. Термин «безусловный» подчеркивает некоторое отли-

чие от принципа максимального правдоподобия, рассмотрен-

ного нами в разд. 3.1. Здесь мы максимизируем безусловную

или совместную функцию плотности р(^,0), которая пред-

ставляет собой основные исходные данные в байесовской по-

становке задачи. С этой целью будем искать то значение 0,

для которого

V0logp(t>, 0) = О (3.3.2а)

для каждого и. Но

р(и, 0) = p(0|v)p(v),

и поэтому нам достаточно вычислить лишь корень уравнения

для градиента

Ve log р (0 | и) = 0.

52

Гл. 3. Теория статистического оценивания

Далее, мы видели, что р(0|у) является гауссовской плот-

ностью со средним Е [01 и], а гауссовская функция плотности

достигает своего максимума в точке, являющейся средним.

Следовательно, безусловно максимально правдоподобная

оценка (БМПО) совпадает с условным средним. Мы проде-

монстрировали это, поскольку работать с формулой (3.3.2а)

проще для важного класса приложений, с которым нам пред-

стоит иметь дело (см. разд. 3.5). Еще важнее то, что байесов-

ская задача оценивания снова сводится к задаче численной

оптимизации — минимизации функционала.

Взаимная информация

Перейдем к вычислению взаимной информации /(0; у), ко-

торая представляет собой «информацию о 0, содержащуюся

в и», и которая по определению (в нашем контексте) есть

Мы можем показать, что

7(0; 0) = Ilog(3.3.15)

Сделаем набросок доказательства этого факта. Во-первых,

log pPiS'p(v) = log Р (0 1 “ log Р (0)>

поэтому

/ (0; v) = Е [log р (0 | и)] - Е [log р (0)],

Отметим, что р(0|у) и р(0) являются гауссовскими. Теперь

легко видеть, что если X—произвольный случайный гауссов-

ский ли-компонентный вектор с дисперсией /?х, то

- log р (X) = у log I Rx I + log 4-

+ 4W (*-£[*]), (X-£[X])J.

Так как

E 1 (X - E [X]), (X - E (X))] =

= Tr E [Ях1 (X - E [X] )(X - E[X] )*] =

= Tr Rx 'E [(X - E [X]) (X - E [X] )*] =

= Tr Rx'Rx = m,

TO

E = [- log p (X)] = 4 log I Rx I + log (W + 4- • (3.3.16)

3.4. Ортогонализация Грамма—Шмидта

55

Поскольку р(0| у) имеет дисперсионную матрицу Р, а р(0)-

имеет дисперсионную матрицу /?©, и обе они размера т X

то, используя (3.3.16) и производя упрощения, получаем

(3.3.15).

Задача 3.3.1

Используя метод характеристических функций, докажите,

что некоррелированные гауссовские величины независимы.

Заметьте, что если даже ковариационные матрицы вырож-

дены, то это не изменяет доказательства.

Задача 3.3.2

Уравнение Винера — Хопфа (3.3.3) представляет собой

линейное уравнение. Покажите, что оно всегда имеет реше-

ние, которое является единственным тогда и только тогда,

когда матрица Е [££*] невырождена.

3.4. Ортогонализация Грамма—Шмидта и разложение

ковариационной матрицы

Пусть X представляет собой /n-компонентный гауссовский

вектор-столбец с нулевым средним, который обозначим

Х=Со1(хь хт).

Пусть Rx обозначает ковариационную матрицу X. Тогда

Rx = {^7/}» 1

где

= Е [xfx7].

Построим новое множество гауссовских величин {yi}, i =

= 1, /и, следующим образом:

#1 = *Ь

Г/2 = х2 — £ [х21 xj.

Г/7 = ХУ —ffxjxj, ...» Xy-J,

-ElXmlXb •••> %т—11*

Заметьте, что {у^}—гауссовские величины, которые имеют ну-

левое среднее. Кроме того,

E[yiyj] = 09 i^j. (3.4.1}

Действительно, для любого I по построению

Е[У}Х1\ = ®> 1= К 2, ...» Z— 1,

54

Гл. 3. Теория статистического оценивания

и поскольку yt представляет собой линейную комбинацию

Xj, . . Ху_ь Ху, то

£[^/1 = 0. /=1, .... I—1.

Для / > i мы воспользуемся тем фактом, что

Е [у{У}] = Е [у^],

чтобы получить (3.4.1). Скажем, что величина yi ортого-

нальна к yh если

Е lyiyj} = 0.

Следовательно, величины {у} взаимно ортогональны. Анало-

гично ковариационная матрица переменной

Г = Со1[^.....ут]

является диагональной:

E[YY*] = D,

где

D = {di/}, dt! = 0, f =/= /.

Заметим, что {у/} можно выразить в следующем виде:

yi = ch\X\ + ai2x2+ ... +а,цхь

где аи=1. Определим матрицу L:

1

где

hi = i < /;

= 0, i > /.

Определенная таким образом матрица L представляет собой

нижнюю треугольную матрицу, и тогда мы получаем

Y = LX.

Определитель нижней треугольной матрицы есть произведе-

ние диагональных элементов, а поэтому в нашем случае

|£|=1.

Поскольку L невырожденная, то

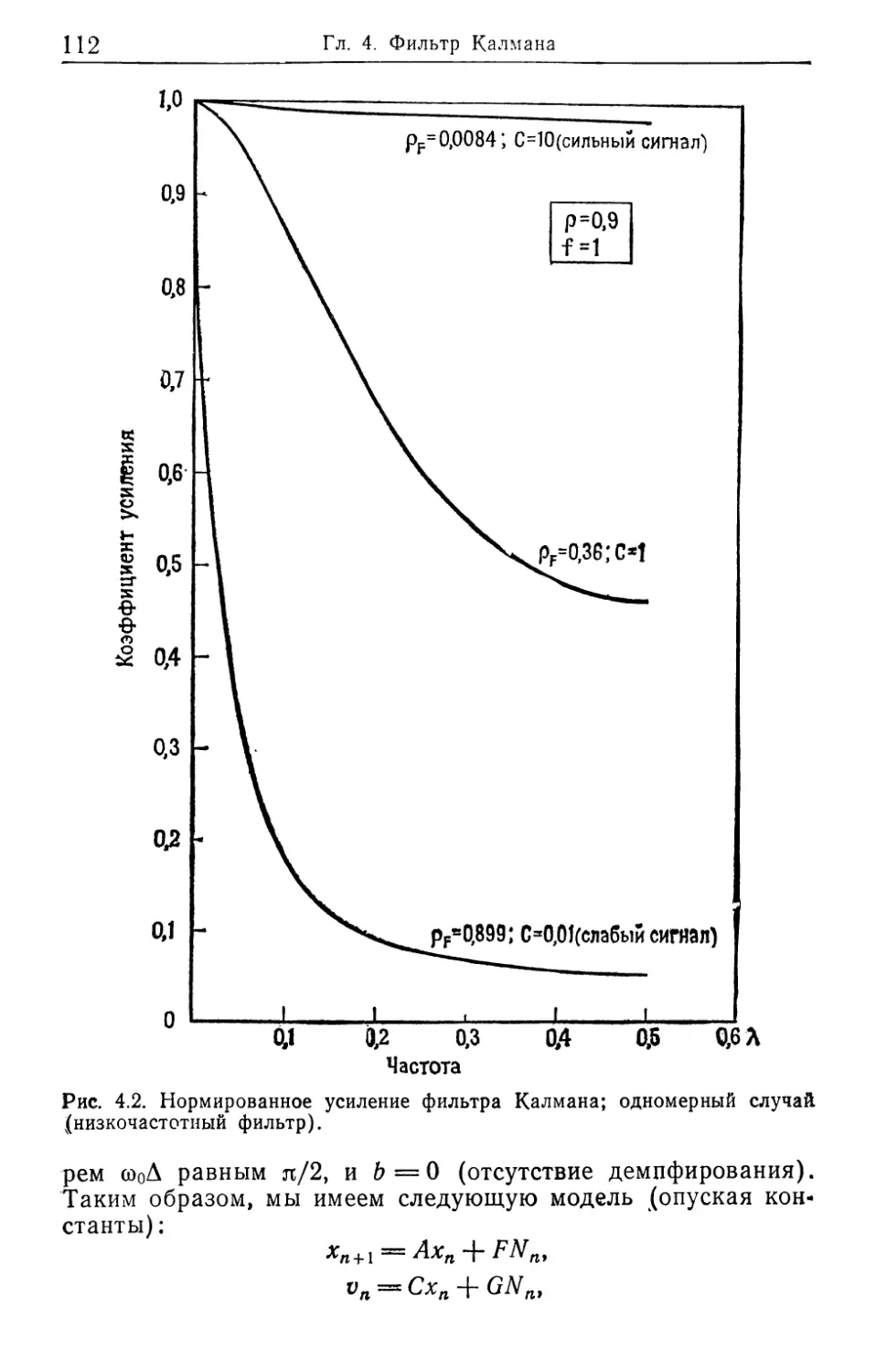

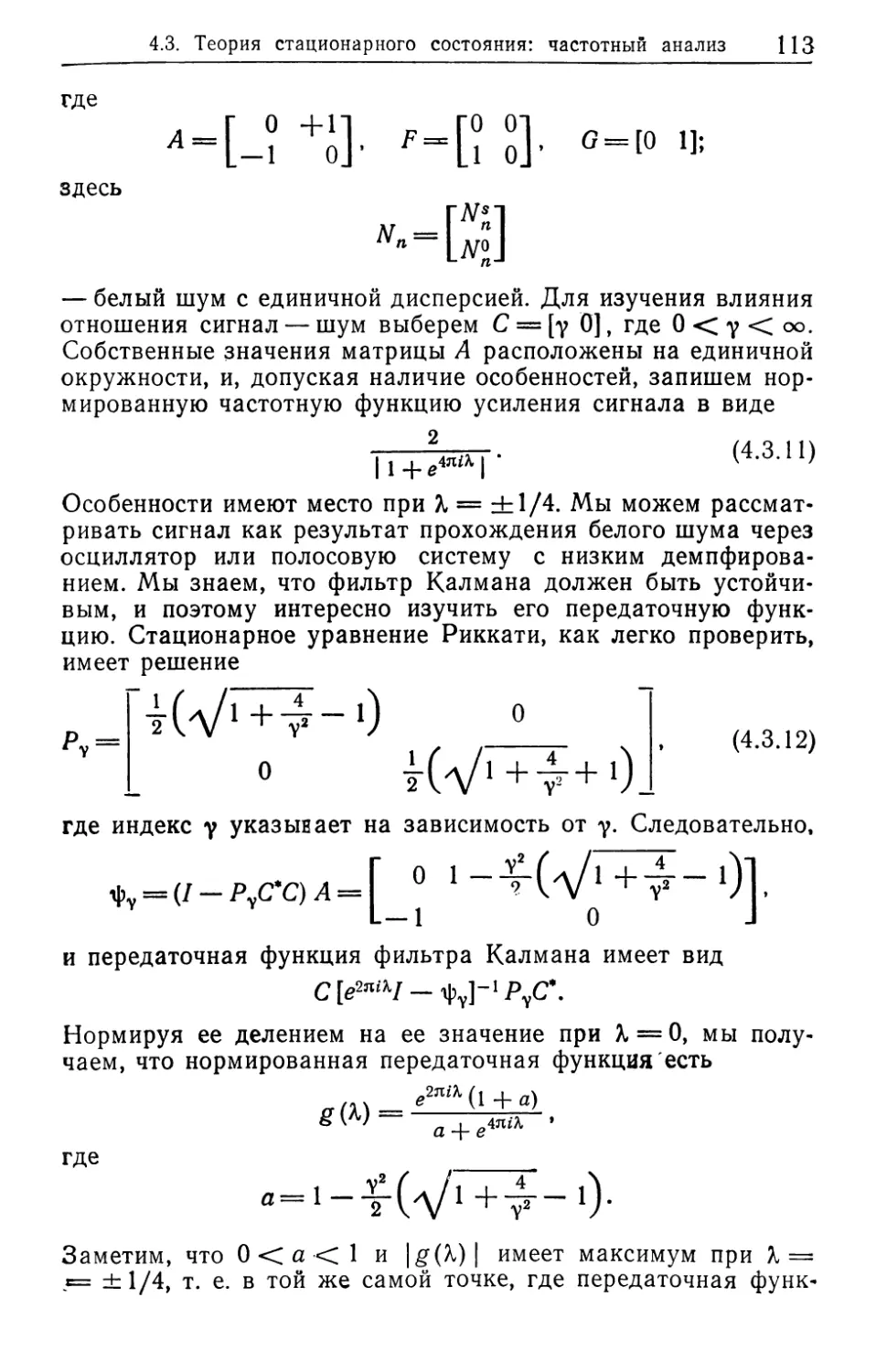

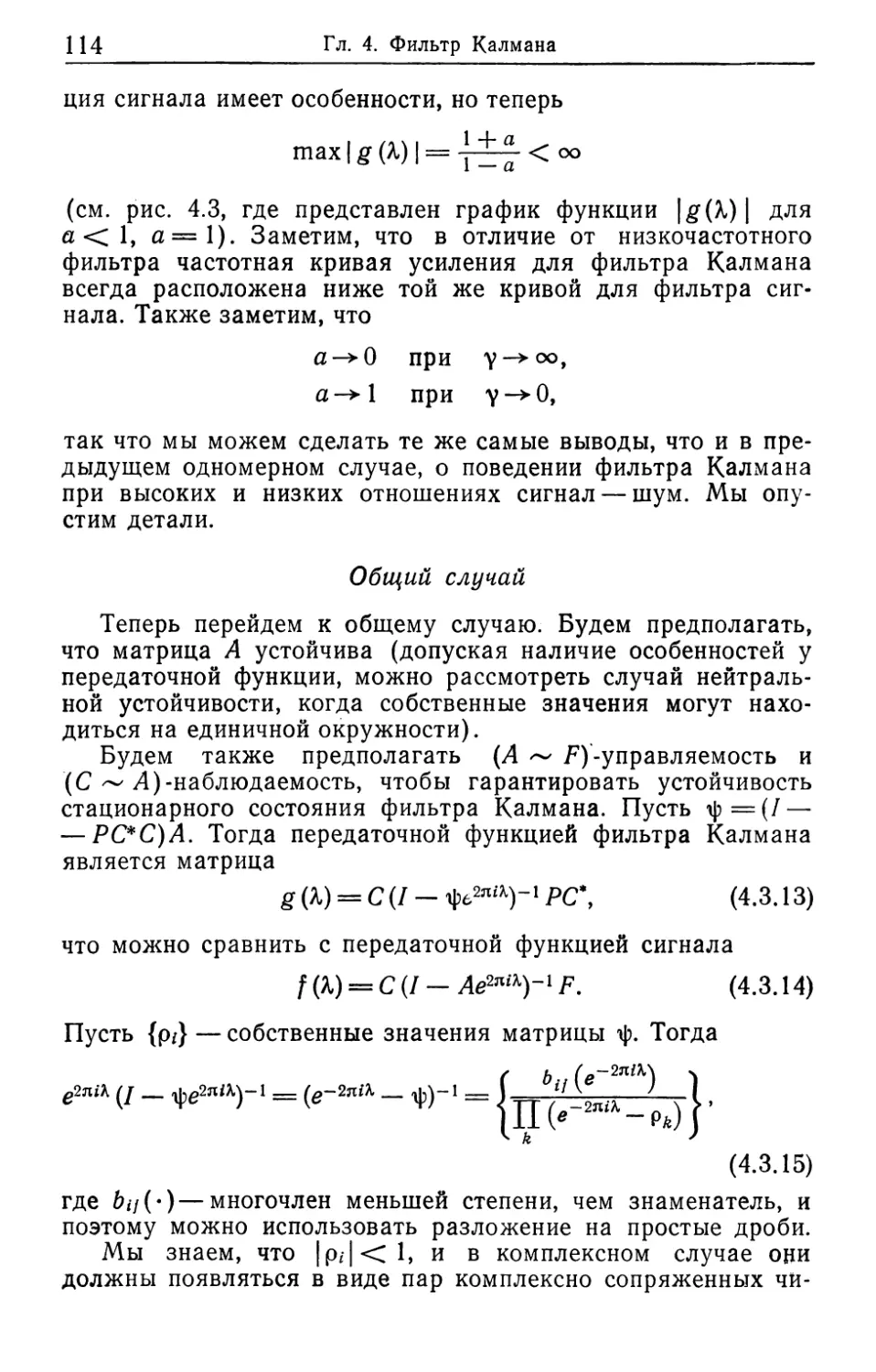

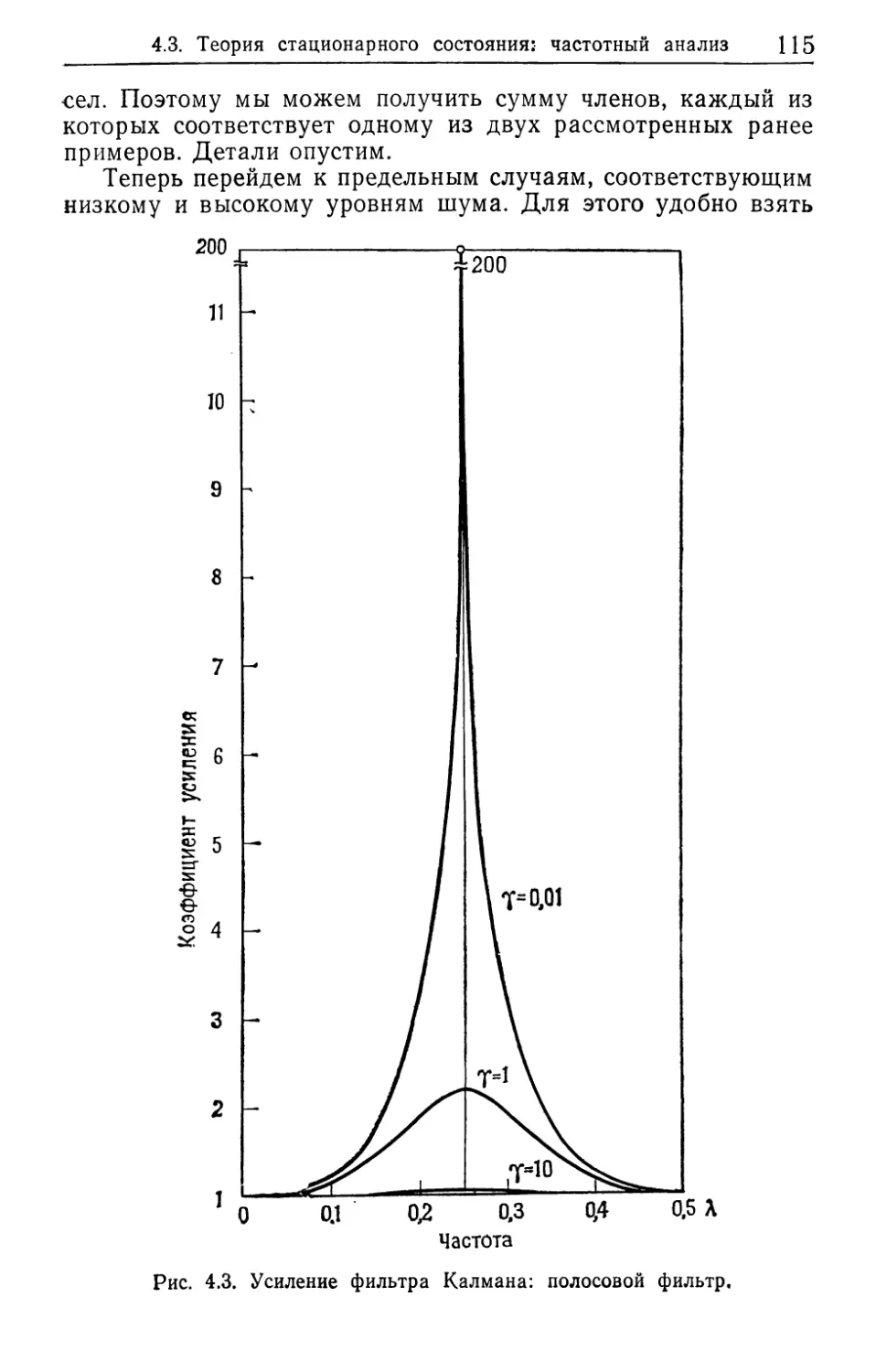

X — L~lY,