Текст

Л.В. ТАРАСОВ

МОСКВА

ФИЗМАТЛИТ

2004

УДК 530.1

ББК 22.3

Т19

Тарасов Л. В. Закономерности окружающего мира. В 3 кн. Кн. 2.

Вероятность в современном обществе. — М.: ФИЗМАТЛИТ, 2004. — 360 с. —

ISBN 5-9221-0516-7.

Данная книга демонстрирует принципиальную роль теории вероятностей в со-

современном обществе, которое основывается на высокоразвитых информационных

технологиях. Книга является достаточно популярным и в то же время строго науч-

научным развернутым введением в исследование операций и теорию информации. Она

имеет четко выраженный учебный характер; ее материал строго структурирован,

построен на доказательной основе, снабжен большим количеством графиков и схем;

приведено значительное количество задач, из которых часть разбирается в книге,

а часть предлагается читателю для самостоятельного решения. Являясь второй

книгой трехтомника автора с общим названием «Закономерности окружающего

мира» (первая книга: «Случайность, необходимость, вероятность», вторая книга:

«Вероятность в современном обществе», третья книга: «Эволюция естественно-

естественнонаучного знания»), данная книга рассматривается в качестве логического продол-

продолжения первой книги, хотя и представляет собой самостоятельный труд.

Для широкого круга читателей и в первую очередь для школьников старших

классов (начиная с 8-го класса), а также студентов техникумов и высших учебных

заведений.

© ФИЗМАТЛИТ, 2004

ISBN 5-9221-0516-7 © Л. В. Тарасов, 2004

Л.В. Тарасов

ВЕРОЯТНОСТЬ

В СОВРЕМЕННОМ

ОБЩЕСТВЕ

Книга вторая

Шк

/

,/

Оглавление

Вступительный диалог автора с читателем

ТЕМА 1. ИССЛЕДОВАНИЕ ОПЕРАЦИЙ: ПРОБЛЕМЫ И ОСНОВНЫЕ

ПОНЯТИЯ, ДИНАМИЧЕСКОЕ ПРОГРАММИРОВАНИЕ 11

1.1 Чем занимается «исследование операций»? 11

1.2 Как оптимизировать решение в многокритериальных задачах? 16

1.3 Динамическое программирование 24

1.4 Беседа по поводу выбора решения в условиях неопределенности 30

ТЕМА 2. ИССЛЕДОВАНИЕ ОПЕРАЦИЙ: МОДЕЛИРОВАНИЕ ОПЕРАЦИЙ

ПО СХЕМЕ МАРКОВСКИХ СЛУЧАЙНЫХ ПРОЦЕССОВ 36

2.1 Марковские случайные процессы с дискретными состояниями

и графы 37

2.2 Марковские процессы с дискретными состояниями и дискретным

временем; переходные вероятности марковской цепи 41

2.3 Самая простая марковская цепь с дискретным временем 43

2.4 Сколько потребуется выстрелов для полного поражения цели? 45

2.5 Поток событий; интенсивность потока 48

2.6 Простейший (пуассоновский) поток событий 51

2.7 Непрерывная марковская цепь и пуассоновский поток событий 53

2.8 Уравнение Колмогорова для предельных вероятностей состояний 57

2.9 Какую рационализацию следует выбрать? 60

ТЕМА 3. ИССЛЕДОВАНИЕ ОПЕРАЦИЙ:

СИСТЕМЫ МАССОВОГО ОБСЛУЖИВАНИЯ 63

3.1 Проблемы массового обслуживания 64

3.2 Основные понятия, используемые в теории массового обслуживания 65

3.3 Виды систем массового обслуживания (СМО) 67

3.4 Схема гибели и размножения 70

3.5 Простейшая СМО — одноканальная система с отказами 74

3.6 Многоканальная СМО с отказами; формулы Эрланга 76

3.7 Сколько требуется каналов обслуживания? 78

3.8 Одноканальная СМО с ограниченной очередью 79

3.9 Насколько целесообразно увеличивать число мест в очереди? 82

3.10 Одноканальная СМО с неограниченной очередью 83

3.11 Какой штраф придется уплатить за ожидание в очереди? 84

3.12 Многоканальная СМО с ограниченной очередью 86

5

3.13 Пример с выбором научно обоснованного решения 89

3.14 Многоканальная СМО с неограниченной очередью 91

3.15 Две одноканальных системы или одна двухканальная? 92

ТЕМА 4. ИССЛЕДОВАНИЕ ОПЕРАЦИЙ: ИГРА И ПРИНЯТИЕ РЕШЕНИЯ 95

4.1 Предмет математической теории игр и основные понятия 96

4.2 Платежная матрица игры, чистые стратегии, смешанные стратегии 100

4.3 Как происходит выбор игроком той или иной чистой стратегии

с заданной вероятностью? 104

4.4 Две такие похожие и такие различные игры 105

4.5 Принцип минимакса; нижняя и верхняя цена игры 107

4.6 Игра с седловой точкой; цена игры 111

4.7 Решение игры без седловой точки и оптимальные смешанные

стратегии 112

4.8 Как найти оптимальную смешанную стратегию для каждого

из игроков? 114

4.9 Геометрическое представление игр 2x2 118

4.10 Геометрическое представление игр 2хпи тх2 122

4.11 Игра «самолеты против зениток» 126

4.12 Упрощение игр. Заведомо невыгодные стратегии 129

ТЕМА 5. ИССЛЕДОВАНИЕ ОПЕРАЦИЙ: ИГРЫ С «ПРИРОДОЙ»,

ИЛИ ПРИНЯТИЕ СТАТИСТИЧЕСКИХ РЕШЕНИЙ 135

5.1 Особенности игр с «природой» 135

5.2 Матрица рисков 138

5.3 Принятие решения, когда известны вероятности «стратегий природы» 139

5.4 Какой из участков следует выбрать под посадку картофеля? 142

5.5 Критерии выбора решения в отсутствие вероятностей «стратегий

природы» 143

5.6 Три критерия и задача с посадкой картофеля 145

5.7 Три критерия и задача с заказом товара 146

ТЕМА 6. «РАБОТАЮЩАЯ СЛУЧАЙНОСТЬ» (МЕТОД МОНТЕ-КАРЛО) 150

6.1 Что такое «метод Монте-Карло»? 151

6.2 Единичный жребий (розыгрыш) как основной элемент статистической

модели 157

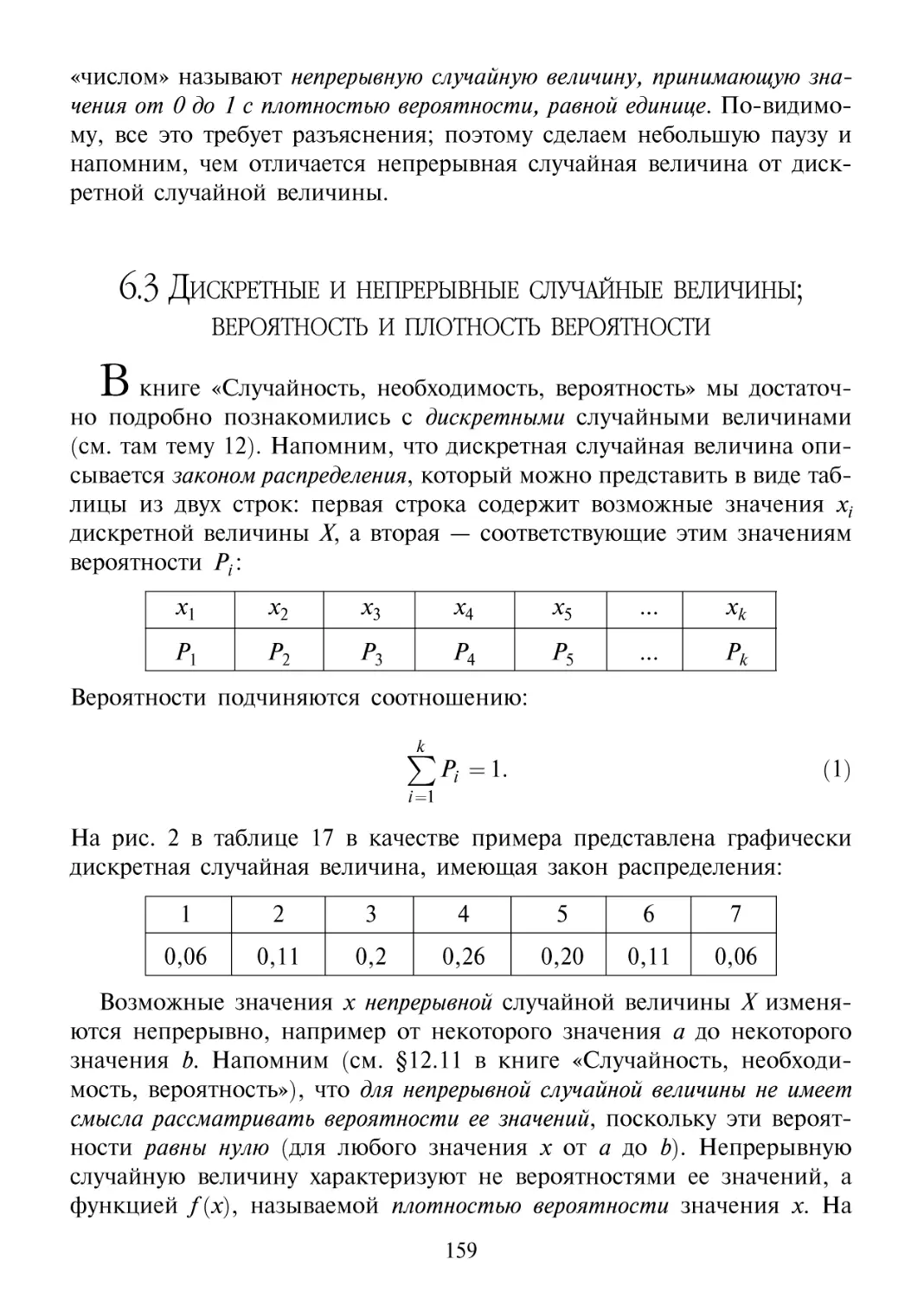

6.3 Дискретные и непрерывные случайные величины; вероятность

и плотность вероятности 159

6.4 «Число R» 162

6.5 Как на практике разыгрывают «число R» 162

6.6 Разыгрывание дискретной случайной величины 164

6.7 Беседа о том, где и когда применяют метод Монте-Карло 166

6

ТЕМА 7. КОЛИЧЕСТВО ИНФОРМАЦИИ И ВЕРОЯТНОСТЬ:

ПРЕДВАРИТЕЛЬНЫЕ СВЕДЕНИЯ И ОСНОВНЫЕ ПРИНЦИПЫ 187

7.1 Предварительные замечания об информации вообще и теории

информации в частности 188

7.2 Математическое отступление, посвященное логарифмической

функции 190

7.3 Игра «Бар-Кохба» — игра в вопросы, предполагающие ответы

только «да» или «нет». 194

7.4 Бит — двоичная единица измерения количества информации 200

7.5 Двоичная система счисления 201

7.6 Формула Хартли. Аддитивность количества информации 203

7.7 Сколько информации можно получить, задавая вопрос,

для которого ответы «да» и «нет» не равновероятны? 207

7.8 Формула Шеннона 210

7.9 Об использовании понятия «энтропия» в теории информации 213

7.10 От информации к выбору, от выбора к информации 215

ТЕМА 8. КОЛИЧЕСТВО ИНФОРМАЦИИ И ВЕРОЯТНОСТЬ:

ПЕРЕДАЧА ИНФОРМАЦИИ ПО КАНАЛУ СВЯЗИ 219

8.1 Общая схема канала связи 220

8.2 Передача сообщений по каналу связи (общие замечания) 224

8.3 Кодирование с использованием равномерных двоичных кодов.

Код Бодо 229

8.4 Кодирование с использованием неравномерных префиксных

двоичных кодов 230

8.5 Энтропия «буквы» и среднее число двоичных цифр, приходящееся

на одну «букву» 233

8.6 Код Хаффмена 237

8.7 Эффективность канала связи с помехами. Взаимная информация

о сообщениях на входе и на выходе 239

8.8 Пропускная способность канала с помехами 246

8.9 Кодирование с целью уменьшения влияния помех и основная

теорема Шеннона 250

ТЕМА 9. ЭНТРОПИЯ В ТЕРМОДИНАМИКЕ 257

9.1 Три этапа в развитии понятия «энтропия» 257

9.2 Краткий экскурс в термодинамику 259

9.3 Цикл Карно 267

9.4 Энтропия как функция состояния макросистемы 269

9.5 Второе начало термодинамики как закон возрастания энтропии

замкнутой системы при необратимых процессах 272

9.6 Загадки термодинамики 274

7

ТЕМА 10. ЭНТРОПИЯ, ВЕРОЯТНОСТЬ, ИНФОРМАЦИЯ 276

10.1 Формула, объясняющая возрастание энтропии при расширении

теплоизолированного газа в пустоту 277

10.2 Микросостояния и макросостояния системы. Статистический вес

(термодинамическая вероятность) макросостояния 279

10.3 Формула Больцмана. Энтропия как мера беспорядка в системе 282

10.4 Статистическое объяснение второго начала термодинамики 283

10.5 Немного о флуктуациях случайных величин 285

10.6 Вероятностная природа второго начала термодинамики 291

Незапланированный диалог 292

10.7 «Демон», владеющий информацией 295

10.8 Формула Больцмана и формула Хартли. Связь между энтропией

и информацией 297

10.9 Формула Шеннона и формула Больцмана 299

10.10 Демонстрация антиэнтропийного (информационного) процесса

при формировании письменных текстов 301

10.11 Между абсолютным порядком и абсолютным беспорядком 308

ТЕМА 11. ЭНТРОПИЯ И ЖИЗНЬ 312

11.1 Краткий экскурс в биологию, посвященный метаболизму 312

11.2 Метаболизм как обмен энтропией (негэнтропией) организма

с окружающей средой 314

11.3 Энтропийные и антиэнтропийные процессы в живом организме 315

11.4 Генетический код; его универсальность 317

11.5 Эволюция жизни на Земле как глобальный антиэнтропийный процесс 320

ТЕМА 12. ЭВОЛЮЦИЯ РОЛИ ВЕРОЯТНОСТИ В ЧЕЛОВЕЧЕСКОМ ОБЩЕСТВЕ

(ОТ ИГРЫ В КОСТИ К НАУЧНО-ТЕХНИЧЕСКОЙ РЕВОЛЮЦИИ

И ИНФОРМАЦИОННОМУ ВЗРЫВУ) 330

Завершающая беседа: информатика и вероятность 336

Часть первая, в которой обсуждается весь спектр проблем, охватываемых

сегодня информатикой 336

Часть вторая, в которой вероятность снова оказывается в центре внимания 344

Часть третья, в которой сообщаются впечатляющие результаты

вычислительного эксперимента по прогнозу глобальных

климатических последствий ядерной войны 352

Список литературы 358

Вступительный диалог автора

с читателем

Какой шаг более важен — первый или второй ?

Без первого шага второй был бы невозможен.

Однако без второго первый шаг мог бы ока-

оказаться ненужным.

Восточная мудрость

Пвтор. В нашем разговоре о закономерностях окружающего мира пер-

первый шаг был сделан в предыдущей книге, озаглавленной «Случайность,

необходимость, вероятность».

'ЧиФнатель. Там этот разговор был всего лишь начат. Не более того.

А на самом деле упомянутая книга являлась развернутым введением в тео-

теорию вероятностей. Закономерностей окружающего мира она, по сути

дела, не рассматривала.

Пвтор. Можно сказать, что она их не рассматривала в явном виде.

Однако неявно она имеет к ним (к закономерностям мира) самое пря-

прямое и непосредственное отношение. Ведь именно вероятности явились

тем математическим аппаратом, который позволил сформулировать за-

закономерности, адекватно отражающие реалии окружающего нас мира.

Эти закономерности принято называть статистическими в отличие от

закономерностей динамических, которые, хотя и позволяют делать од-

однозначные предсказания, но дают весьма упрощенное представление о

мире, ограничиваясь рассмотрением идеализированных схем. Именно

через вероятности выражается присущее реальному миру диалектическое

единство таких противоположностей как необходимость и случайность.

Так что книгу «Случайность, необходимость, вероятность» следует рас-

рассматривать отнюдь не только как введение в теорию вероятностей, но и

как начало разговора о закономерностях окружающего нас мира (см.,

в частности, темы 1 и 2, имеющие названия: «Случайные события: про-

против и за» и «Порядок и беспорядок»).

'ЧиФИОФъель. По-видимому, теперь настало время сделать второй шаг —

поговорить о закономерностях окружающего мира обстоятельно и на-

напрямую?

9

Пвтор. Именно такова цель данной книги. Закономерности окружаю-

окружающего мира мы постигаем в процессе познания мира. Этот процесс тес-

теснейшим образом связан с развитием нашей способности активно и це-

целенаправленно действовать в реальном мире. Мир полон случайностей.

И чтобы познать его, человек должен был научиться учитывать эти слу-

случайности в своей целенаправленной деятельности, рассматривая их

не только в качестве своих противников, но также в качестве союзни-

союзников и помощников.

'Чининпель. В том, что мир полон случайностей, человек убедился

давно. Поэтому-то с давних времен он и относится к случайностям как

к фактору, препятствующему его целенаправленной деятельности. Воз-

Возможность же использовать случайности в качестве каких-то помощни-

помощников человек усматривал, пожалуй, лишь в гаданиях, толкованиях снов,

различных предметах. В основном он уповал на божий промысел. И впол-

вполне понятно, что издавна закономерности мира отождествлялись, по

большому счету, с законами религии.

Пвтор. Надо признать, что ничего другого и не оставалось делать

человеку в обществе, где понятие вероятности еще не родилось. Когда

же оно родилось, ситуация принципиально изменилась. Теперь вопрос

о постижении мира, его закономерностей, места человека в мире вы-

вышел, по сути дела, за религиозные рамки. Открылась возможность на-

научного рассмотрения этого вопроса, а именно возможность постижения

мира через вероятность, через вероятностные закономерности.

Мы намерены рассмотреть данную тему в двух аспектах, посвятив

им, соответственно, вторую и третью книги нашего трехтомника.

Первый аспект предполагает обращение к современному обществу.

Сегодня на дворе XXI-й век. Он начался с информационного взрыва.

Ему пророчат название века информации. Многообразные информацион-

информационные системы, как и само понятие количества информации (равно как и

понятие информационной энтропии), органически связаны с понятием

вероятности. Уже поэтому вероятность оказывается «ключевым словом»

в современном обществе. Об этом мы и поговорим во второй книге трех-

трехтомника, озаглавленной «Вероятность в современном обществе».

Второй аспект предполагает обращение к истории естествознания, а

точнее, к эволюции естественнонаучной картины мира, связанной с

постепенно углубляющимся процессом научного познания человеком

окружающего его мира. Этот процесс убедительно продемонстрировал

фундаментальность вероятностных (статистических) закономерностей,

которые стали сегодня подлинной основой научного миропонимания. Об

этом мы будем говорить в третьей книге трехтомника, озаглавленной

«От динамических закономерностей к вероятностным».

10

ТЕМА 1

ИССЛЕДОВАНИЕ ОПЕРАЦИЙ:

ПРОБЛЕМЫ И ОСНОВНЫЕ ПОНЯТИЯ,

ДИНАМИЧЕСКОЕ ПРОГРАММИРОВАНИЕ

Потребности практики вызвали к жизни

специальные научные методы, которые удоб-

удобно объединять под названием «исследование

операций». Под этим термином мы будем

понимать применение математических, ко-

количественных методов для обоснования ре-

решений во всех областях целенаправленной

человеческой деятельности.

Е. С. Вентцелъ

1.1 Чем занимается «исследование операций»?

Jt5 самых общих чертах ответ на этот вопрос содержится в приве-

приведенном выше эпиграфе: исследование операций занимается применением

11

математики для принятия обоснованных решений в различных областях

человеческой деятельности.

Принимать решения всем нам приходится постоянно, изо дня в день.

На какое время завести будильник? Что выбрать на завтрак? Брать ли с

собой зонтик, выходя из дома? С кем сегодня связаться по телефону?

И так далее. Разумеется, все подобные решения принимаются без ка-

каких-либо специальных математических расчетов и не имеют отноше-

отношения к «исследованию операций». Нельзя считать «исследованием опе-

операций» и принятие более серьезных решений. Куда отправиться отдыхать

летом? Как уберечься от гриппа в период эпидемии? Как обезопасить

квартиру от грабителей? Как наладить хорошие отношения с родителями

жены (мужа)? Оптимизация подобных решений (т.е. выбор наиболее ра-

разумных и эффективных решений) происходит на основе жизненного

опыта, с учетом советов окружающих людей, информации, получаемой

из телевидения, журналов, газет. Математические расчеты тут не при-

применяются. Выбор не совсем удачного решения здесь не очень стра-

страшен — ведь он затрагивает интересы всего лишь одного или нескольких

человек. Как известно, на ошибках учатся.

Иное дело, если приходится принимать решения, затрагивающие ин-

интересы многих людей, а потому требующие весьма ответственного отно-

отношения. Допустим, требуется организовать в городе работу обществен-

общественного транспорта. Пусть это будут автобусы. В этом случае нужно принять

целый ряд решений. Какие маршруты выбрать? Как разметить останов-

остановки? Как выбрать частоту следования автобусов в зависимости от време-

времени суток? Сколько автобусов направлять по тому или иному маршруту?

Как организовать техническое обслуживание парка автобусов? Неопти-

Неоптимальный выбор совокупности подобных решений может существенно

усложнить нормальную жизнь горожан. Поэтому здесь было бы умест-

уместно воспользоваться соответствующими математическими расчетами, т. е.,

иначе говоря, заняться «исследованием операций». К сожалению, не-

нередко решения в таких случаях принимаются интуитивно, исходя из

опыта и соображений здравого смысла. И если у страдающего манией

собственной непогрешимости руководителя окажется недостаточно опы-

опыта и здравого смысла, то принятые им «волевые» решения вполне могут

«подарить» горожанам постоянную проблему с общественным транс-

транспортом. Да и не только с ним.

Чем сложнее, масштабнее планируемое мероприятие, тем менее по-

позволительны «волевые» решения. Тем более важными становятся пред-

предварительные математические расчеты, которые могут помочь выбрать

научно обоснованные оптимальные решения и предостеречь от ис-

12

пользования тех или иных неудачных вариантов (вариантов, менее вы-

выгодных в экономическом или социальном отношении). Именно такими

математическими расчетами и занимается наука, называемая «исследо-

«исследованием операций».

Под операцией понимается в этой науке любая совокупность дей-

действий (любое мероприятие), преследующих достижение какой-то цели.

Рассматривая конкретную операцию, мы ищем оптимальное (наиболее

разумное) решение, т. е. определяем такой набор зависящих от нас па-

параметров (факторов), который бы в наибольшей степени обеспечивал

достижение поставленной цели. В зависимости от выбора этих пара-

параметров принятые решения могут оказаться в той или иной мере менее

разумными или же вообще явно неудачными. Набор параметров, опре-

определяющих то или иное решение, образует множество элементов реше-

решения. Предположим, составляется план перевозок однотипных грузов из

пунктов отправления АХАЪ А3в пункты назначения Въ Въ Въ, В4я вы-

выбрано решение, согласно которому грузы из пункта Ах поступают в пунк-

пункты Въ Въ В3в количестве, равном, соответственно пц9 пи, я13, а грузы

из А2я ^43П0СТУпают в ^4В количестве, равном, соответственно, я24, Л34-

В данном случае числа ли, пп, я13, #24? пъа являются элементами выб-

выбранного решения.

Как оценивать степень разумности (лучше сказать, степень эффек-

эффективности) того или иного решения? Для этого вводят количественный

критерий, называемый показателем эффективности. Его выбирают, ис-

исходя из той цели, которая ставится в данной операции. Оптимальным

считается то решение, при котором показатель эффективности (его обыч-

обычно обозначают через W) окажется экстремальным — максимальным или

минимальным. Если, например, критерием эффективности выбран до-

доход от данной операции, то желательно, чтобы показатель эффектив-

эффективности оказался максимальным (записывают так: Ж^>тах). Если же

критерием выбраны затраты на проведение операции, то желательно,

чтобы показатель эффективности оказался минимальным (записывают:

W^> min).

Приведем несколько достаточно простых примеров.

Пример 1. Операция — снабжение ряда предприятий сырьем со скла-

складов с тем, чтобы потребности в сырье были обеспечены при минимуме

расходов на перевозки. Показатель эффективности W — расходы на

перевозки, скажем, за месяц; W^> min.

Пример 2. Операция — сооружение участка железнодорожной магист-

магистрали в минимально возможные сроки (необходимо распределить технику

и рабочих по участкам пути, продумать земляные работы, обеспечить

13

участки шпалами и рельсами, предусмотреть ремонтные работы и т. д.).

Показатель эффективности W — среднее ожидаемое время завершения

стройки; W^ min.

Пример 3. Операция — проведение медицинского обследования жи-

жителей некоторого района, где обнаружены случаи опасного заболева-

заболевания, с целью выявления заболевших и носителей инфекции (необходи-

(необходимо определить число медпунктов, разместить их по территории района,

установить последовательность осмотров специалистами, проведения

анализов и т. д.). Показатель эффективности W — средний процент вы-

выявленных больных носителей инфекции; W^ max.

Пример 4. Операция — проведение выборочного контроля изделий,

выпускаемых некоторым заводом, с целью обеспечения заданного ка-

качества изделий при минимальных расходах на контроль (необходимо

выбрать объем контрольной партии, набор соответствующих тестов,

правила браковки и т. д.). Показатель эффективности W— средние ожи-

ожидаемые расходы на контроль за единицу времени; W^ min.

Пример 5. Операция — продажа сезонных товаров с целью получе-

получения максимального дохода (необходимо определить число торговых то-

точек и характер размещения их с учетом спроса, учесть ассортимент то-

товаров, предусмотреть рекламу и т. д.). Показатель эффективности W —

средний ожидаемый доход по окончании распродажи; W^ max.

Заметим, что в четырех из пяти приведенных примеров показатель

эффективности имеет эпитет «средний». Дело в том, что при рассмот-

рассмотрении данных операций надо принимать во внимание различные слу-

случайные факторы. Как говорят, в подобных случаях решение принимается

в условиях неопределенности. Именно с такими случаями как раз и при-

приходится обычно иметь дело на практике. Поэтому позднее мы погово-

поговорим о них подробнее.

А пока отметим еще одну особенность приведенных примеров. Здесь

рассматривался всякий раз лишь один показатель эффективности. Од-

Однако эффективность операции, как правило, нельзя охарактеризовать

одним критерием. Особенно если речь идет о достаточно серьезных и

крупномасштабных операциях, направленных на достижение сразу не-

нескольких различных целей. В соответствующих задачах исследования опе-

операций приходится использовать не один, а несколько показателей эф-

эффективности. Такие задачи называют многокритериальными.

Допустим, организуется работа некоторого промышленного предприя-

предприятия. Конечно, хотелось бы получить максимальный возможный доход

Wi (Wi =^> max). В то же время хотелось бы минимизировать себестои-

14

мость продукции W2 (W^^>min). При этом желательно, чтобы оказа-

оказалась максимальной производительность труда W3 (Ж3^>тах).

Возвращаясь к примеру с продажей сезонных товаров, отметим, что

получение наибольшего дохода может являться отнюдь не единствен-

единственной целью, так что средняя ожидаемая прибыль Wx (Wi=> max) — это

всего лишь один из показателей эффективности. Возможно, что орга-

организаторы продажи заинтересованы также в том, чтобы время проведе-

проведения торгов было поменьше (ведь аренда торговых точек стоит недеше-

недешево); поэтому возникает еще один показатель эффективности — время

проведения торгов W2 (W2 =^> min). Чтобы побыстрее распродать това-

товары, надо позаботиться о хорошей рекламе, об увеличении числа торго-

торговых точек и продавцов. Все это потребует, конечно, дополнительных

расходов, которые хотелось бы минимизировать. В результате появля-

появляется третий показатель эффективности — расходы, связанные с органи-

организацией и проведением торгов JV3 (Ж3^>тах). Можно, наконец, пред-

предположить, что организаторы продажи, думая «на перспективу» (т. е.

заботясь об успешности распродажи товаров в последующие сезоны),

пожелают представить свои товары наибольшему количеству посетите-

посетителей (потенциальных покупателей). В связи с этим появляется четвер-

четвертый показатель эффективности — среднее число людей JV4, посетивших

в данном сезоне соответствующие торговые точки (^^>тах).

Итак, как правило, есть несколько показателей эффективности, одни

из которых желательно обратить в максимум, а другие, напротив, в

минимум. Выбор совокупности показателей эффективности — задача

не такая простая и, конечно же, не имеющая в каждом конкретном

случае однозначного решения. Как выбор показателей эффективности,

так и расположение их по степени важности существенно зависят от

того, с точки зрения чьих интересов оптимизируется решение в данной

операции.

Различают прямые и обратные задачи исследования операций. Обо-

Обозначим через Xмножество решений хъ хъ х3,..., хь хп,...9 которые воз-

возможны при рассмотрении некоторой конкретной операции. Выберем

какое-то решение xt из множества 1и выясним, чему равен показатель

эффективности для данного решения. Это есть прямая задача. При не-

необходимости ее следует рассмотреть для всех п возможных решений.

Другой подход к исследованию операций состоит в том, чтобы выявить

такое решение х* из множества X, при котором показатель эффектив-

эффективности примет экстремальное значение. Это есть обратная задача — за-

задача отыскания оптимального решения. Понятно, что обратная задача

сложнее прямой. Особенно, если она является многокритериальной.

15

Предположим, что число возможных решений, образующих множе-

множество X, относительно мало. В этом случае для решения однокрите-

риальной обратной задачи можно попросту рассмотреть прямую задачу

для каждого из решений хъ х2,..., хП9 получить, соответственно, п значе-

значений показателя эффективности W, сравнить их между собой и непо-

непосредственно указать один или несколько оптимальных вариантов. Та-

Такой способ отыскания оптимального решения называют способом простого

перебора.

Если учитываются несколько критериев, то надо рассмотреть пря-

прямую задачу для каждого из п возможных решений и каждого из показа-

показателей эффективности. При учете, например, трех критериев надо полу-

получить 3п величин: W{\ JV?,..., W?\ W\, W%,..., W?\ W\, Wf,..., Щ (здесь

и в дальнейшем нижний индекс фиксирует номер показателя эффек-

эффективности в многокритериальной задаче, а верхний индекс фиксирует

номер решения из множества X). Сравнивая друг с другом все эти

Ъп величин, можно попытаться выбрать то решение (или те решения),

которое представляется наиболее разумным.

Когда число возможных решений велико, метод простого перебора

даже в однокритериальных задачах может оказаться затруднительным

или вообще непригодным. В таких случаях используют методы направ-

направленного перебора вариантов. Все они основаны на том, чтобы отыскать

оптимальное решение путем последовательных «попыток» (последова-

(последовательных «приближений»), которые шаг за шагом приближают нас к ра-

разумному решению.

1.2 Как оптимизировать решение

в многокритериальных задачах?

'Чи&атель. Большинство задач исследования операций многокрите-

многокритериальные; они учитывают несколько показателей эффективности. Как

я понимаю, многокритериальное^ не создает особых проблем при рас-

рассмотрении прямых задач. На зато возникают серьезные проблемы с

обратными задачами, т. е. задачами на отыскание оптимальных реше-

решений. Можно ли полностью оптимизировать решение в многокрите-

многокритериальной задаче? Иначе говоря, существуют ли способы отыскания ре-

решения, которое являлось бы оптимальным сразу по всем показателям

эффективности, рассматриваемым в многокритериальной задаче?

Пвтор. Надо сразу сказать: такое невозможно в принципе. Решение,

обращающее в максимум (минимум) один из показателей эффектив-

16

ности, не может обеспечить экстремальные значения также и всех ос-

остальных показателей эффективности.

*Чи(*иипель. Однако нередко можно слышать призывы добиться мак-

максимального эффекта при минимуме затрат.

Пвтор. Это не более, чем красивая фраза. В математических расчетах

ее не надо принимать во внимание. Невозможно сделать так, чтобы,

как говорится, «и волки были сыты, и овцы были целы». Возьмем, к

примеру, уже обсуждавшуюся нами операцию по продаже сезонных

товаров. Мы рассматривали четыре показателя эффективности: сред-

среднюю ожидаемую прибыль Wx [Wx =^>max), время проведения торгов W2

(Ж^тт), расходы на их организацию и проведение W3 (Ж3^тт),

среднее число посетителей торговых точек W4 (W4=>max). Очевидно,

что, максимизируя прибыль, невозможно минимизировать расходы. Ми-

Минимизируя расходы, нельзя максимизировать прибыль. Стремясь уве-

увеличить число посетителей (потенциальных покупателей), мы, естествен-

естественно, должны увеличивать число торговых точек и число продавцов,

подумать о дополнительной рекламе. Значит, мы должны не умень-

уменьшать, а увеличивать расходы и, уж во всяком случае, не должны стре-

стремиться к сокращению времени проведения торгов. Легко видеть, что

оптимизация по одним показателям оказывается несовместимой с оп-

оптимизацией по другим показателям.

*Чипиииель. А нельзя ли свести многокритериальную задачу к одно-

критериальной, составив из различных показателей эффективности ка-

какой-то обобщенный показатель, который и следует максимизировать или

минимизировать?

Пвтор. Есть ли у Вас идея, как это сделать?

*Чи(*иипель. Да, такая идея есть. Почему бы не представить обобщен-

обобщенный показатель JVo6 в виде дроби? Числитель дроби — произведение

всех показателей эффективности, которые желательно максимизиро-

максимизировать, а знаменатель — произведение показателей, которые желательно

минимизировать. Оптимальным можно считать решение, обращающее

в максимум показатель JVo6, т. е. эту дробь. В нашем примере с прода-

продажей товаров показатель Wo6 можно было бы представить дробью

При увеличении ^и W4w уменьшении Ж2я JV3обобщенный показа-

показатель Wo6 будет, очевидно, возрастать. Вот и надо из всех возможных

решений выбрать то, для которого этот показатель окажется наиболь-

наибольшим. Оно и будет оптимальным решением.

Пвтор. На первый взгляд, такая идея может показаться разумной.

Однако рекомендовать ее не следует.

17

. Почему же?

Пвтор. По той простой причине, что из факта максимизация показа-

показателя Wo6 отнюдь нельзя заключить, что состоялась оптимизация по каж-

каждому из показателей Wh Wb W3, W4. Вы исходили из утверждения,

состоящего в том, что, если бы удалось максимизировать И^и И^и

минимизировать Ж2и Ж3, то произойдет максимизация JVo6...

Ъиниинелй. Простите, но разве это утверждение неверно?

Пвтор. Это утверждение верно. Но суть Вашей идеи заключается в

том, чтобы воспользоваться обратным утверждением. А вот оно-то не-

неверно. Нельзя утверждать, что, если произошла максимизация Wo6, то

удалось максимизировать Wln W4и минимизировать W2n W3. Мы встре-

встречаемся здесь с ситуацией, когда прямая теорема справедлива, а обратная

несправедлива.

g4u<StiuSU*&. Уточните, о каких теоремах идет речь.

Пвтор. Пусть обобщенный показатель эффективности есть дробь,

где числителем является произведение частных показателей, подлежа-

подлежащих максимизации, а знаменателем — произведение показателей, под-

подлежащих минимизации. Прямая теорема', если частные показатели эф-

эффективности максимизированы (минимизированы), то обобщенный

показатель в виде упомянутой дроби будет максимизирован. Эта теоре-

теорема справедлива, поскольку при увеличении числителя и уменьшения

знаменателя дроби сама дробь возрастает. Обратная теорема', если дроб-

дробный обобщенный показатель эффективности максимизирован, то част-

частные показатели эффективности будут максимизированы (минимизиро-

(минимизированы). Это теорема несправедлива.

ttufauSt&fib. Вообще-то следовало бы доказать последнее утверждение.

Пвтор. Дело в том, что увеличение числителя и уменьшение знамена-

знаменателя дроби есть достаточное, но отнюдь не необходимое условие возраста-

возрастания самой дроби. Дробь может расти, например, и при уменьшении чис-

числителя, если при этом знаменатель будет уменьшаться еще быстрее. Так,

в примере с продажей товаров может оказаться, что решение xt с наи-

наибольшим показателем Wo6 будет обеспечивать явно низкие показатели

Wln W4, если при этом показатели W2n W3будут особенно низкими.

Иначе говоря, максимум JVo6 вполне может быть достигнут при недости-

недостижении целей 1 и 4 (получение дохода и привлечение покупателей) за счет

«перевыполнения» по целям 2 и 3 (сокращение времени торгов и сокра-

сокращение расходов). Понятно, что в данном случае оптимизация по обоб-

обобщенному показателю отнюдь не решает проблемы оптимизации по всем

частным показателям. Коротко говоря, нельзя «компенсировать» непо-

неполучение доходов за счет сокращения расходов.

18

. Все-таки хотелось бы иметь доказательство несправедли-

несправедливости обратной теоремы в общем виде.

Пвтор. Воспользуемся методом доказательства от противного. Пред-

Предположим, что обратная теорема справедлива, т. е. из оптимизации по

обобщенному показателю эффективности следует оптимизация по всем

частным показателям. Это будет означать, что оптимизация одновре-

одновременно по всем частным показателям эффективности в принципе осу-

осуществима. Но такое невозможно. Следовательно, предположение о том,

что обратная теорема справедлива, не проходит и необходимо признать,

что эта теорема несправедлива.

*Чи(*иипель. Пожалуй, обобщенные показатели в виде дроби в самом

деле не годятся. А если попытаться скомбинировать частные показате-

показатели эффективности не в виде дроби, а как-то иначе?

Пвтор. Одна из таких попыток состоит в том, чтобы составить из

показателей Wb W2, W^ ..., Ws обобщенный показатель в виде «взве-

«взвешенной суммы»:

Wo6 = axWx + a2W2 + a3W3 + ... + asWs, (**)

где аъ аъ я3,..., as — весовые коэффициенты, выбираемые с учетом

степени важности соответствующего показателя эффективности. Эти

коэффициенты положительны для показателей, подлежащих максими-

максимизации, и отрицательны для показателей, подлежащих минимизации.

*Чи(*иипель. Весовые коэффициенты — это разумно! Принимая реше-

решение с учетом различных факторов, мы часто взвешиваем мысленно все

«за» и все «против» и приписываем больший вес тем факторам, которые

представляются нам более важными. Формула (**) мне нравится.

Пвтор. Однако не спешите брать ее на вооружение. Различные пока-

показатели эффективности — это величины, имеющие, как правило, разные

размерности. Получается, что в (**) надо складывать слагаемые разной

размерности, что, очевидно, недопустимо. В примере с продажей това-

товаров пришлось бы, например, складывать деньги со временем и числом

покупателей.

'Читатель. Выходит, что с помощью математики можно оптимизиро-

оптимизировать решения лишь для однокритериальных операций, а в многокрите-

многокритериальных операциях следует ограничиваться только прямыми задачами?

Пвтор. Нет, это не так. Математический аппарат может быть с успе-

успехом применен также и к обратным многокритериальным задачам. Про-

Просто не надо пытаться заменить совокупность показателей эффективно-

эффективности неким обобщенным показателем — это заведомо тупиковый путь,

поскольку нельзя свести несколько различных целей к одной. Вместо

19

этого надо воспользоваться идеей компромисса — когда каждый из по-

показателей эффективности максимизируется (минимизируется) не в пол-

полной мере.

ёЧи<9ии9се*ь. Чтобы в какой-то мере были сыты волки и в какой-то

мере сохранялось поголовье овец?

Пвтор. Примерно так. Но прежде, чем искать компромиссное реше-

решение, целесообразно выявить из множества X возможных решений те

решения, которые уступают по всем рассматриваемым критериям хотя

бы одному решению из X. Эти решения как заведомо менее удачные можно

в дальнейшем не рассматривать. После отбрасывания заведомо менее

удачных решений множество X может существенно сократиться. Оста-

Останутся только те решения, среди которых не окажется ни одного, усту-

уступающего по всем показателям эффективности какому-либо из осталь-

остальных решений. Такие решения называют эффективными или паретовскими

(по имени итальянского экономиста Вилъфредо Парёто A848-1923),

который пытался математически обосновать концепцию взаимозависи-

взаимозависимости различных экономических факторов). Окончательное решение

выбирают из совокупности паретовских решений в процессе поиска

компромисса.

*Чипии*иль. Хорошо бы все это как-то проиллюстрировать.

Пвтор. Это удобно сделать, рассматривая некоторую задачу с двумя

показателями эффективности Wxyl W2 (двухкритериальную задачу). Пусть

для определенности оба показателя требуется максимизировать (Wx =^> max,

W2 =^> max). Решая прямую задачу, мы можем найти значения показа-

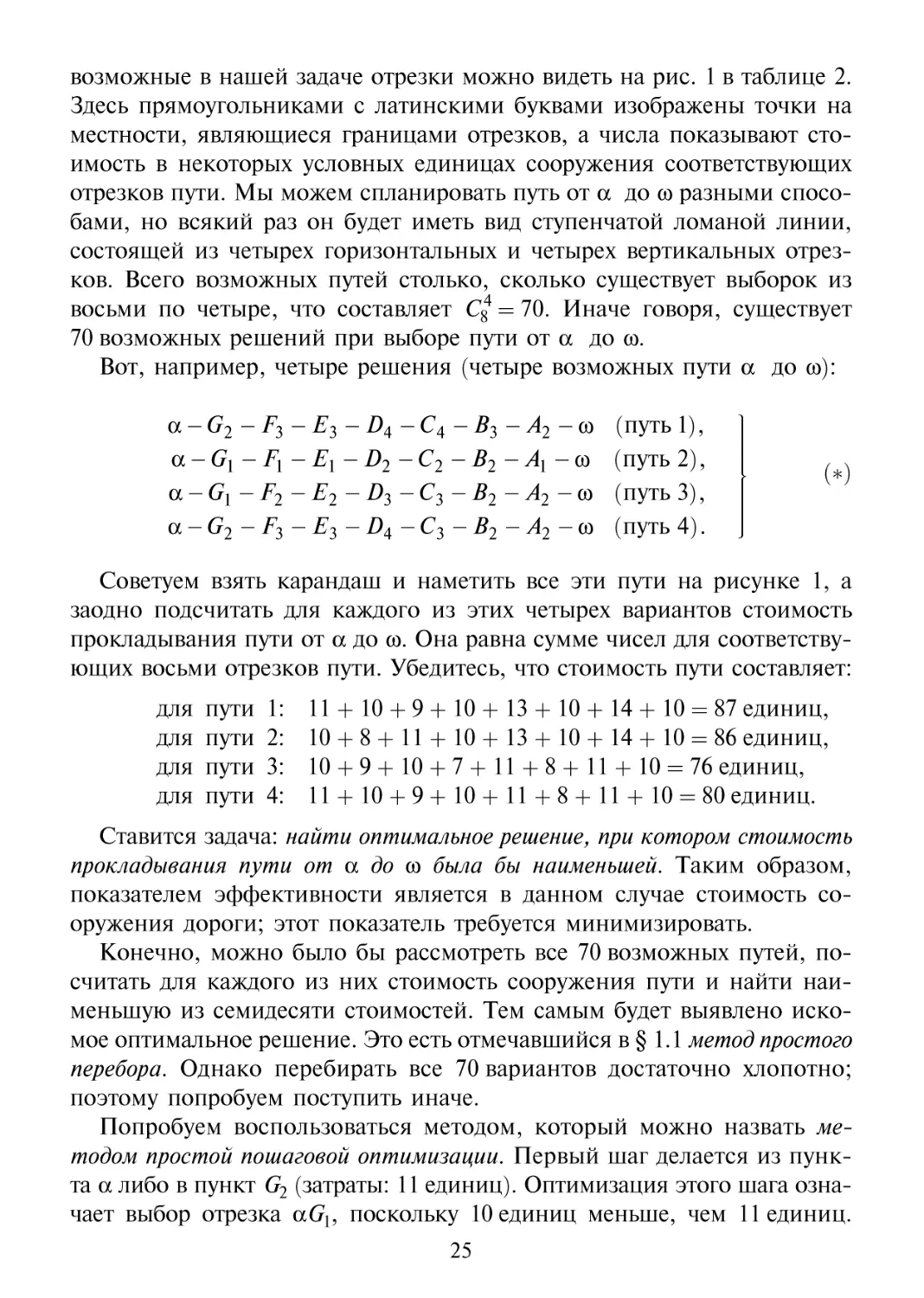

показателей Жхи Ж2для каждого из возможных решений. На рис. 1 в табли-

таблице 1 рассмотрены 4решения (хъ хъ х3, ха)- По оси ^отложены отве-

отвечающие этим решениям значения показателя Wx (они обозначены через

W{\ JV?9 JV?9 W{4), апооси W2 - значения показателя W2 {W\, Wl W\, W%)\

сами решения изображены в виде точек на плоскости Wx— W2 (точки

1, 2, 3, 4). Будем полагать, что всего для данной операции рассматрива-

рассматриваются 18 возможных решений — все они показаны точками на плоско-

плоскости Wi - JV2ua рисунках 2, Зи 4в таблице 1. Рассмотрим рисунок 2.

При условии Wi =^> max и W2 =^> max множество паретовских решений

состоит из решений 13, 2, 6, 9, 7. Любое из остальных тринадцати реше-

решений уступает по обоим показателям эффективности хотя бы одному из

пяти паретовских решений и может в дальнейшем не рассматриваться.

Например, решение 16 вытесняется (принято говорить «доминируется»)

решением 13 (Ж/6< Ж/3; W26 < W23), а решение 11 доминируется ре-

решением 9 (Ж/1 = Wl\ W\x < Wt).

20

Таблица 1. Двухкритериальные задачи исследования операций

W22

W23

w4

1 f

II

11

! !

• 2

I 4

I I

Рис.1

W,3 W2W4

I i

I

W2

16*

1

*5

10

•

17

®-

13

3

•

12

15.

18*

14

2

Ni

4

§^

11 *\

•

47

8*

Рис.2

W,

w2

16

13

• •

AW,

f

„• I

Рис.3

W,

Рис.4

AW,

^4

2,

•6

w,

min

Рис.5 W2

f

• 3

•11

10

•9

w,

Wi ^> min

Рис.6 W2 => max

4.

/lO

<¦' I' w.

•11

W! =>max

Рис.7 W2 => min

21

. А если количество показателей эффективности будет боль-

больше двух? Предположим, рассматриваются четыре показателя, из кото-

которых три (Wi, Wb W$) надо максимизировать, а один (JV4) минимизиро-

минимизировать. Как быть в этом случае?

Пвтор. Представить ситуацию графически тут уже нельзя. Но можно

для каждого из п возможных решений (xl5 хъ х3,..., хп) отыскать четвер-

четверку показателей эффективности: {Wl, W\, W\, W\), {W\, W2, Wf, W%),...,

{W\y W", W", W%). Затем надо сравнить все п получившихся четверок

показателей между собой и забраковать каждую четверку (а значит, и

соответствующее решение), для которой найдется хотя бы одна среди

остальных четверок, доминирующая над этой четверкой. Иначе говоря,

если найдется хотя бы одна четверка, для которой показатели Wh Wb W3

больше, а показатель JV4 меньше по сравнению с данной четверкой.

&. Ну, хорошо. Допустим, мы выявили паретовские реше-

решения. Что делать дальше?

Пвтор. Возвращаемся к примеру с двухкритериальной задачей. Оце-

Оценив ситуацию, мы можем потребовать, чтобы показатель W2 был не меньше

некоторой определенной величины w2. Предположим, эта величина нахо-

находится между W2n W2 — см. рис. 2 в таблице 1. В этом случае паретов-

паретовские решения 9 и 7 следует исключить, а из оставшихся паретовских

решений (решений 13, 2 и 6) надо выбрать то, для которого окажется

наибольшим показатель Wx. Это есть решение 6.

ёЧи<9ии9се*ь. Как я понимаю, после того, как было наложено ограни-

ограничение w2ua показатель эффективности Wb задача стала, по сути дела,

однокритериальной и нам осталось оптимизировать по показателю Wx все

решения хь для которых W{^w2.

Пвтор. Совершенно верно. Мы могли бы, кстати говоря, и не отыс-

отыскивать паретовские решения, а сразу изъять из рассмотрения те реше-

решения xi9 для которых W{ < w2. тогда у нас остались бы решения 16, 1, 13,

12, 2, 6 — см. рис. 3 в таблице 1. Среди этих решений выбираем то, для

которого показатель ^является наибольшим. Получаем решение 6.

g4utftiuSU*b. Предположим, что мы считаем показатель Wx значительно

более важным, чем показатель W2. Наверное, в этом случае следует выб-

выбрать из паретовских решений (решений 13, 2, 6, 9, 7) то решение, для

которого показатель эффективности Wx наибольший, т. е. следует оста-

остановиться на решении 7. Не так ли?

Пвтор. Не совсем так. Существует метод отыскания компромиссно-

компромиссного решения, называемый методом последовательных уступок. Допустим,

показатель ^важнее показателя W2. Находим сначала решение, обра-

обращающее в максимум показатель Wx — это есть, как мы уже выяснили,

22

решение 7. Затем, исходя из практических соображений (из того, на-

насколько более важен показатель W{) назначаем некоторую «уступку» AWh

которую мы соглашаемся сделать, чтобы максимизировать показатель W2.

В связи с этим потребуем, чтобы выполнялось условие Wx > W± - AWX.

При таком условии выбираем из паретовских решений то, которое об-

обращает в максимум показатель W2. Это есть решение 9 — см. рис. 2

в таблице 1.

. По-видимому, мы могли бы воспользоваться данным ме-

методом, не тратя времени на поиск паретовских решений?

Пвтор. Да, могли бы. Из восемнадцати возможных решений xt надо

убрать из рассмотрения те, для которых W[ < Wl - AWX. Тогда останут-

останутся решения 8, 7, 11 и 9 — см. рис. 4 в таблице 1. Из этих решений выби-

выбираем решение с наибольшим W2; это есть решение 9.

*Чскп<14пель. Данный метод Вы назвали «методом последовательных

уступок». Какие последовательные уступки имеются здесь в виду?

Пвтор. Предположим, что рассматриваются не два, a s критериев.

Расположим s показателей эффективности в порядке постепенного убы-

убывания их важности: Wb W2, W$,..., Ws. Наиболее важен показатель Wb

наименее важен показатель Ws. После первой уступки (уступки AW{) мы

максимизировали показатель W2w нашли решение, для которого этот

показатель имеет значение W2. Далее назначаем вторую уступку вели-

величиной AWb ценой которой максимизируем показатель W3, и находим

решение с показателем W3. Затем назначаем третью уступку величи-

величиной в АЖ3, ценой которой максимизируем показатель Wx. И так да-

далее — до тех пор, пока не будет максимизирован показатель Ws.

^СшОаАел*. На рисунках 2, 3 и 4 рассматривались двухкритериальные

ситуации, когда Wx ^> max и W2 ^> max. Неплохо бы рассмотреть графи-

графически также ситуации: a) Wx ^> min, W2 ^> min, б) Wx ^> min, W2 ^> max,,

в) Wi ^> max, W2 ^> min.

Пвтор. Ситуации а), б), в) представлены графически, соответственно,

на рисунках 5, 6 и 7 в таблице 1. Паретовские решения изображены здесь

кружочками с точками внутри. Горизонтальные пунктирные прямые за-

задают ограничения на значения показателя эффективности W2. Попро-

Попробуйте самостоятельно выбрать окончательное (компромиссное) решение

в каждой из трех ситуаций двумя способами — учитывая ограничение по

показателю W2 и используя метод последовательных уступок.

*Чи(*иипель. Возвращаясь к проблеме компромисса, хотелось бы по-

поговорить о том, каким образом определяется степень важности того или

иного показателя эффективности в многокритериальных задачах.

23

Пвтор. Это решается отдельно для каждой конкретной операции и

является выбором, который должен сделать руководитель операции.

Именно за ним остается последнее (и подчас решающее) слово.

*4caftfufie*&. Получается, что здесь есть немало произвола?

Пвтор. Конечно. Важно, чтобы этот произвол не сводился к приня-

принятию решений наобум, а опирался на предварительные математические

расчеты. Понятно, что эти расчеты не приведут к жестким, однознач-

однозначным решениям. Однако они позволят избежать принятия заведомо не-

неудачных решений и подскажут решения, которые могут считаться дос-

достаточно разумными.

"ЧитОФнел^. Выходит, что исследование операций — это не просто

наука, но и в какой-то степени искусство?

Пвтор. Вы правы. Тут уместно привести шутливое высказывание од-

одного из зарубежных специалистов. Он заметил, что «исследование опе-

операций представляет собой искусство давать плохие ответы на те прак-

практические вопросы, на которые даются еще худшие ответы другими

методами».

1.3 Динамическое программирование

в

качестве конкретного примера оптимизации решения в детерми-

детерминированном случае (в случае, когда все условия операции известны зара-

заранее и не содержат неопределенности) рассмотрим одну из задач дина-

динамического программирования. Термин «программирование» является

данном случае синонимом термина «планирование»; его не надо путать

с программированием на ЭВМ. Под динамическим программированием

понимают метод оптимизации решений, применяемый в операциях,

которые можно разбить на последовательные «шаги». На каждом шаге

выбирается оптимальное решение, позволяющее получить максималь-

максимальный выигрыш в операции в целом.

Для иллюстрации метода динамического программирования рассмот-

рассмотрим следующую задачу с намеренно упрощенными условиями. Нужно

соорудить дорогу от пункта а до пункта со, лежащего к северо-востоку

от а. Для простоты полагаем, что весь путь от а до со разбит на восемь

отрезков (восемь «шагов») и что на каждом отрезке дорога идет или

строго на восток (горизонтальный отрезок), или строго на север (верти-

(вертикальный отрезок). Полагаем также, что из восьми отрезков пути четыре

отрезка являются горизонтальными и четыре — вертикальными. Все

24

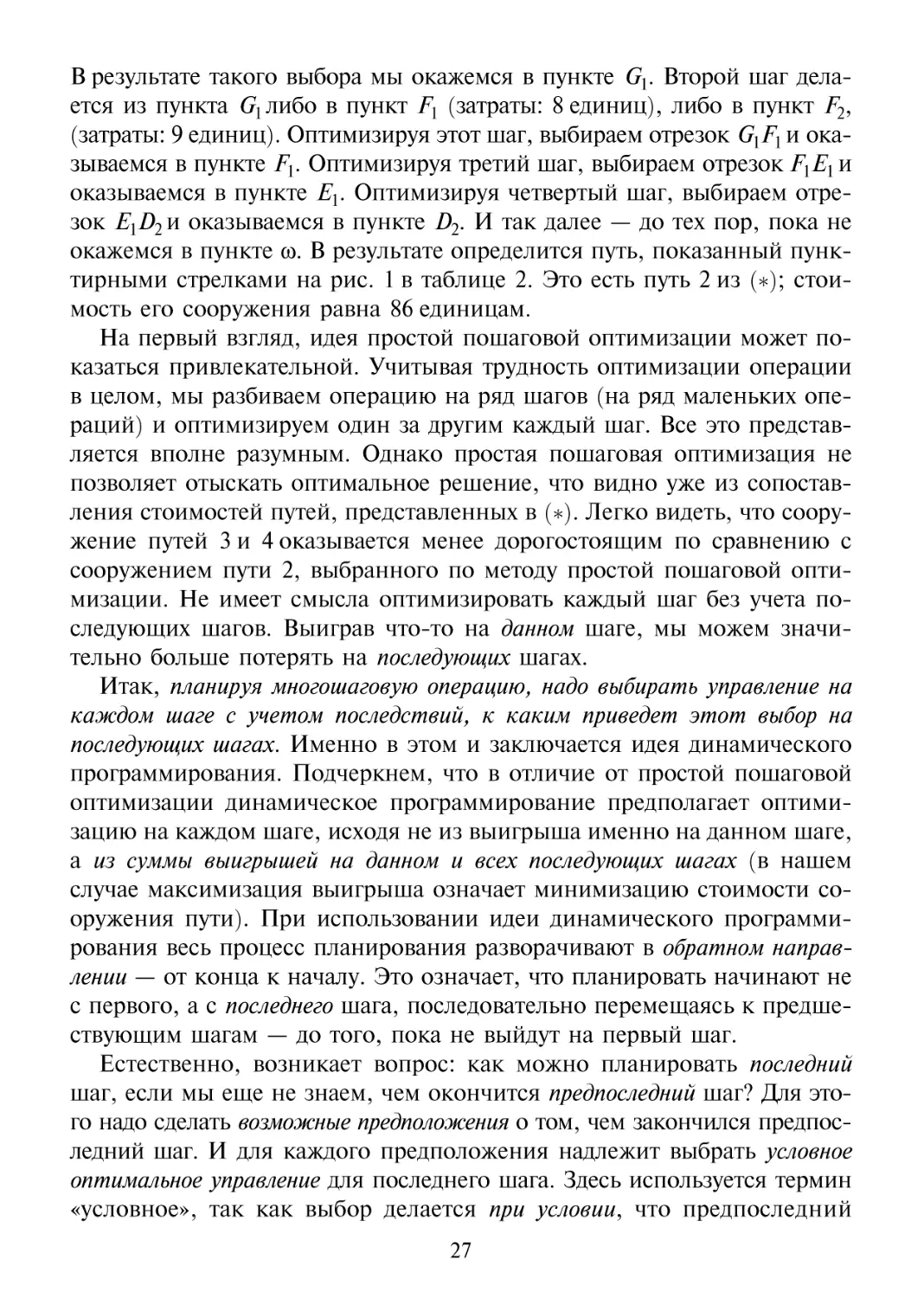

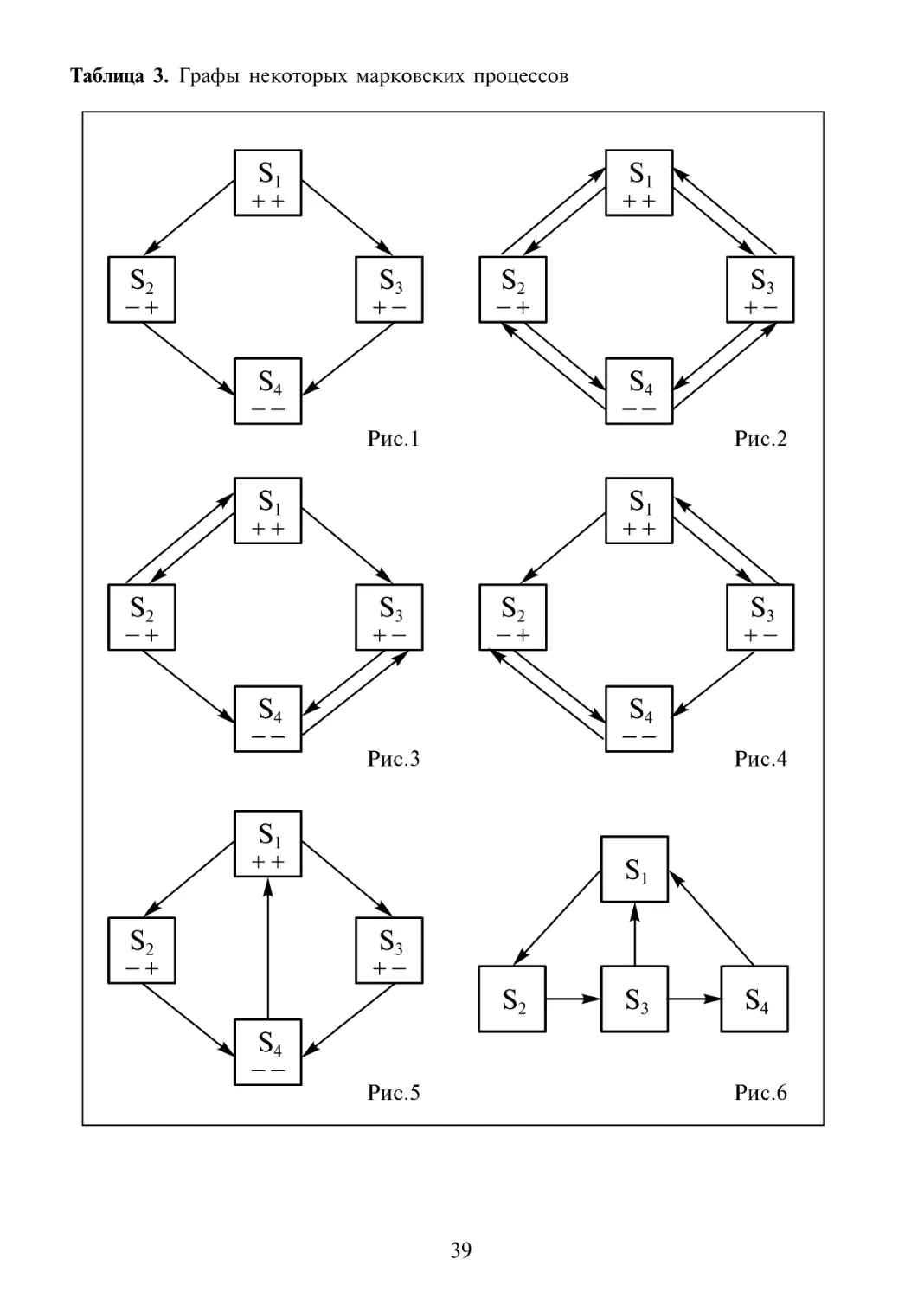

возможные в нашей задаче отрезки можно видеть на рис. 1 в таблице 2.

Здесь прямоугольниками с латинскими буквами изображены точки на

местности, являющиеся границами отрезков, а числа показывают сто-

стоимость в некоторых условных единицах сооружения соответствующих

отрезков пути. Мы можем спланировать путь от а до со разными спосо-

способами, но всякий раз он будет иметь вид ступенчатой ломаной линии,

состоящей из четырех горизонтальных и четырех вертикальных отрез-

отрезков. Всего возможных путей столько, сколько существует выборок из

восьми по четыре, что составляет С84 = 70. Иначе говоря, существует

70 возможных решений при выборе пути от а до со.

Вот, например, четыре решения (четыре возможных пути а до со):

a-G2- F3- E3- DA-CA-B3- А2-ы (путь 1),

a-Gl-Fl-El-D2-C2-B2-Al-a (путь 2),

а - Gx - F2 - Е2 - Z>3 - С3 - В2 - А2 - со (путь 3),

a-G2-F3-E3-D4-C3-B2-A2-co (путь 4).

(*)

Советуем взять карандаш и наметить все эти пути на рисунке 1, а

заодно подсчитать для каждого из этих четырех вариантов стоимость

прокладывания пути от а до со. Она равна сумме чисел для соответству-

соответствующих восьми отрезков пути. Убедитесь, что стоимость пути составляет:

для пути 1: 11 + 10 + 9 + 10 + 13 + 10 + 14 + 10 = 87 единиц,

для пути 2: 10 + 8 + 11 + 10 + 13 + 10 + 14 + 10 = 86 единиц,

для пути 3: 10 + 9 + 10 + 7 + 11 + 8 + 11 + 10 = 76 единиц,

для пути 4: 11 + 10 + 9 + 10 + 11 + 8 + 11 + 10 = 80 единиц.

Ставится задача: найти оптимальное решение, при котором стоимость

прокладывания пути от а до со была бы наименьшей. Таким образом,

показателем эффективности является в данном случае стоимость со-

сооружения дороги; этот показатель требуется минимизировать.

Конечно, можно было бы рассмотреть все 70 возможных путей, по-

посчитать для каждого из них стоимость сооружения пути и найти наи-

наименьшую из семидесяти стоимостей. Тем самым будет выявлено иско-

искомое оптимальное решение. Это есть отмечавшийся в § 1.1 метод простого

перебора. Однако перебирать все 70 вариантов достаточно хлопотно;

поэтому попробуем поступить иначе.

Попробуем воспользоваться методом, который можно назвать ме-

методом простой пошаговой оптимизации. Первый шаг делается из пунк-

пункта а либо в пункт G2 (затраты: 11 единиц). Оптимизация этого шага озна-

означает выбор отрезка aGh поскольку 10 единиц меньше, чем 11 единиц.

25

Таблица 2. Пример решения задачи динамического программирования

5| РИС.1

14

Рис.2

29 Сз

12

24 В3

I10

34 с4

Рис.4

Рис.3

Рис.5

26

В результате такого выбора мы окажемся в пункте Gj. Второй шаг дела-

делается из пункта б^либо в пункт Fx (затраты: 8 единиц), либо в пункт F2,

(затраты: 9 единиц). Оптимизируя этот шаг, выбираем отрезок G^F^ и ока-

оказываемся в пункте Fx. Оптимизируя третий шаг, выбираем отрезок РХЕХ и

оказываемся в пункте Ех. Оптимизируя четвертый шаг, выбираем отре-

отрезок E1D2n оказываемся в пункте D2. И так далее — до тех пор, пока не

окажемся в пункте со. В результате определится путь, показанный пунк-

пунктирными стрелками на рис. 1 в таблице 2. Это есть путь 2 из (*); стои-

стоимость его сооружения равна 86 единицам.

На первый взгляд, идея простой пошаговой оптимизации может по-

показаться привлекательной. Учитывая трудность оптимизации операции

в целом, мы разбиваем операцию на ряд шагов (на ряд маленьких опе-

операций) и оптимизируем один за другим каждый шаг. Все это представ-

представляется вполне разумным. Однако простая пошаговая оптимизация не

позволяет отыскать оптимальное решение, что видно уже из сопостав-

сопоставления стоимостей путей, представленных в (*). Легко видеть, что соору-

сооружение путей 3 и 4 оказывается менее дорогостоящим по сравнению с

сооружением пути 2, выбранного по методу простой пошаговой опти-

оптимизации. Не имеет смысла оптимизировать каждый шаг без учета по-

последующих шагов. Выиграв что-то на данном шаге, мы можем значи-

значительно больше потерять на последующих шагах.

Итак, планируя многошаговую операцию, надо выбирать управление на

каждом шаге с учетом последствий, к каким приведет этот выбор на

последующих шагах. Именно в этом и заключается идея динамического

программирования. Подчеркнем, что в отличие от простой пошаговой

оптимизации динамическое программирование предполагает оптими-

оптимизацию на каждом шаге, исходя не из выигрыша именно на данном шаге,

а из суммы выигрышей на данном и всех последующих шагах (в нашем

случае максимизация выигрыша означает минимизацию стоимости со-

сооружения пути). При использовании идеи динамического программи-

программирования весь процесс планирования разворачивают в обратном направ-

направлении — от конца к началу. Это означает, что планировать начинают не

с первого, а с последнего шага, последовательно перемещаясь к предше-

предшествующим шагам — до того, пока не выйдут на первый шаг.

Естественно, возникает вопрос: как можно планировать последний

шаг, если мы еще не знаем, чем окончится предпоследний шаг? Для это-

этого надо сделать возможные предположения о том, чем закончился предпос-

предпоследний шаг. И для каждого предположения надлежит выбрать условное

оптимальное управление для последнего шага. Здесь используется термин

«условное», так как выбор делается при условии, что предпоследний

27

шаг закончился соответствующим образом. Затем мы переходим к вы-

выбору предпоследнего шага и делаем возможные предположения о том,

чем закончился предпредпоследний шаг. Для каждого предположения

выбираем условное оптимальное управление для предпоследнего шага.

И так далее. Постепенно «пятясь назад», оптимизируем управление на

разных шагах — и в конечном итоге доходим до первого шага. В резуль-

результате выявляется искомое оптимальное решение; это есть решение, со-

состоящее из тех выборов, какие мы сделали в процессе нашего мыслен-

мысленного перемещения от конца многошаговой операции к ее началу.

А теперь проделаем все это на конкретном примере, обратившись к

нашей операции по минимизации затрат на сооружение пути от а до со.

Итак, начинаем с рассмотрения последнего (восьмого) шага — см. рис. 2 в

таблице 2. Если в результате предпоследнего (седьмого) шага мы оказа-

оказались в пункте Аъ то последний шаг будет состоять в сооружении отрез-

отрезка пути А^ы стоимостью в 14 единиц. Если в результате седьмого шага

мы оказались в пункте Аъ то последний шаг будет состоять в сооруже-

сооружении отрезка пути А2ю стоимостью в 10 единиц. Короче говоря, мы с

необходимостью отправляемся в со как из пункта Аъ так и из пункта А2

(см. на рисунке короткие стрелки). Тут нам пока выбирать нечего.

Далее рассматриваем предпоследний, т. е. седьмой шаг — см. рис. 3 в

таблице 2. Тут следует сделать три предположения. Первое: после шес-

шестого шага мы оказались в пункте Вх. Дальнейший путь в этом случае

предопределен, тут нам выбирать нечего. Это есть путь В1-А1- со; ука-

указываем его с помощью двух коротких стрелок — от В{к Аъ а затем от

А1к со. Сооружение данного пути имеет стоимость 12 + 14 = 26 единиц;

число 26 записываем в прямоугольнике Вх. Второе предположение: после

шестого шага мы оказались в пункте ^ Ив этом случае дальнейший

путь предопределен: В3-А2-ю (его стоимость: 14 + 10 = 24 единицы).

Третье предположение: после шестого шага мы оказались в пункте В2.

Вот теперь у нас появляется выбор: либо сооружать путь В2 - А1 - со стои-

стоимостью в 10 + 14 = 24 единицы, либо сооружать путь В2 -А2 - со стои-

стоимостью в 11 +10 = 21 единицу. Поскольку 21 меньше, чем 24, мы вы-

выбираем путь В2-А2-сд и отмечаем это на рисунке двумя короткими

стрелками — от В2 к Аъ а затем от А2 к со. Тем самым мы осуществили в

отношении седьмого шага условное оптимальное управление (оно осу-

осуществлено при условии, что после шестого шага мы оказались в В2).

Далее рассматриваем, продолжая «пятиться назад», шестой шаг —

см. рис. 4 в таблице 2. Тут следует сделать четыре предположения. Пер-

Первое: после пятого шага мы оказались в Q. В этом случае дальнейший

путь предопределен: С\ - В1 -А1 - со (его стоимость: 10 + 12 + 14 = 36 еди-

28

ниц). Второе предположение: мы оказались после пятого шага в С4. И в

этом случае дальнейший путь предопределен: С4-В3-А2-ю (его стои-

стоимость: 10 + 14 + 10 = 34 единицы). Третье предположение: после пятого

шага мы оказались в С2. Тут у нас есть выбор: либо из С2 отправиться в Въ

а затем в А1 и со (стоимость сооружения пути из С2: 11 + 12 + 14 = 37 еди-

единиц), либо из С2 отправиться в Въ а затем проследовать по уже выбран-

выбранному нами на седьмом шаге маршруту от В2к Аъ от А2к со (стоимость

сооружения такого пути из С2: 10+11 + 10 = 31 единица). Осуществляя

условное оптимальное управление, мы выбираем второй вариант, по-

поскольку 31 меньше, чем 37. Отмечаем сделанный выбор короткими стрел-

стрелками от С2к Въ от i?2K Аъ от А2 к со и записываем число 31 в прямо-

прямоугольнике С2. Четвертое предположение: после пятого шага мы оказались

в С3. Тут тоже есть выбор: либо путь С3- Въ-А2- со стоимостью в

12 + 14 + 10 = 36 единиц, либо путь С3- В2-А2-ю стоимостью в

8 + 11 + 10 = 29 единиц. Осуществляя условное оптимальное управле-

управление, выбираем второй вариант, поскольку 29 меньше, чем 36. Отмечаем

этот выбор короткими стрелками и записываем число 29 в прямоуголь-

прямоугольнике С3.

Аналогичным образом рассматриваем последовательно пятый, затем

четвертый, третий, второй, первый шаги. В итоге получаем схему, изоб-

изображенную на рис. 5 в таблице 2. Здесь число внутри того или иного

прямоугольника показывает суммарную стоимость прокладывания оп-

оптимального пути от данного прямоугольника (от данного пункта) до

конечного пункта со. Этот оптимальный путь прослеживаться по корот-

коротким стрелкам. Возьмем, к примеру, пункт Еъ. В соответствующем пря-

прямоугольнике стоит число 50. Значит, оптимальный (наиболее дешевый)

путь от Еъ к со имеет стоимость в 50 единиц. Этот путь прослеживается

по коротким стрелкам: от Е3к Z>4, от D4k С3, от С3к В2, от В2к Аъ от А2

к со A0+11 + 8 + 11 + 10 = 50).

Оптимальный путь из начального пункта а в конечный пункт со име-

имеет, как показано на рисунке 5, стоимость в 76 единиц. Проследив его по

коротким стрелкам, убеждаемся, что есть путь 3 из (*):

а - Gx - F2 - Е2 - D3 - С3 - В2 - А2 - со.

Так как это как раз и есть искомое оптимальное решение, изобразим

данный путь на рис. 5 с помощью толстых стрелок.

Метод динамического программирования применяют для оптимиза-

оптимизации решения в самых различных операциях — лишь бы их можно было

разбить на этапы (шаги). Понятие «этапа» (шага) в различных опера-

операциях может иметь разный смысл. В рассмотренном выше примере под

29

«этапами» понимались отдельные участки прокладываемого пути от а

к со. Восемь участков пути (восемь отрезков) — восемь этапов.

«Шагами» многошаговой операции часто бывают временные этапы.

Например, планируется на т лет работа двух групп предприятий, из

которых первая выпускает предметы потребления, а вторая ремонтиру-

ремонтирует и производит оборудование и механизмы для производства предме-

предметов потребления, т. е. обслуживает предприятия первой группы. Цель

операции — получение за т лет максимального объема выпуска пред-

предметов потребления. В соответствии с этим требуется оптимально опре-

определить долю капиталовложений в первую группу предприятий (а зна-

значит, и во вторую группу) на первый год, на второй год, на третий год и

так далее. Недальновидный руководитель в погоне за сиюминутным

выигрышем может вложить уже в первом году почти все выделенные

средства в предприятия первой группы, практически проигнорировав

поддержание и развитие предприятий второй группы. Дальновидный

руководитель воспользуется методом динамического программирования

и подсчитает, сколько средств следует вкладывать каждый год в пред-

предприятия первой группы и предприятия второй группы, чтобы в целом за

т лет (а не только в первые один-два года!) объем выпуска предметов

потребления оказался максимальным.

Укажем еще один пример многошаговой операции, которую можно

исследовать, используя метод динамического программирования. Рас-

Рассматривается вывод на орбиту многоступенчатой космической ракеты.

Пусть число ступеней равно т. Процесс вывода ракеты на орбиту со-

состоит из т этапов, каждый из которых завершается сбрасыванием оче-

очередной ступени. Динамическое программирование позволяет ответить

на вопрос: как надо распределить массу по т ступеням ракеты, чтобы

скорость ракеты при ее выходе на орбиту оказалась максимальной?

1.4. Беседа по поводу выбора решения

в условиях неопределенности

Пвтор. В общем случае показатель эффективности W (или совокуп-

совокупность таких показателей) зависит от трех групп факторов: заранее извест-

известных факторов (обозначим их всех через а), случайных факторов (обо-

(обозначим их через ?), решения х9 выбранного нами из множества X

возможных решений. Мы можем представить: W= W{a, ?; x). Если

фактор ? отсутствует, то говорят о выборе решения в детерминированном

30

случае. В общем же случае этот фактор присутствует — и мы имеем дело

с выбором решения в условиях неопределенности.

g4tuftiufie*b. Ранее мы рассматривали пример с распродажей товаров.

Давайте уточним, какие факторы входят здесь в группу а, а какие — в

группу ?. Ограничимся показателем эффективности W, связанным с полу-

получением прибыли от продажи. Этот показатель нужно максимизировать.

Пвтор. Под а здесь следует понимать выделенные средства на при-

приобретение товаров для продажи (или сами товары), средства на оплату

труда продавцов и на рекламу, предоставленные под торги помещения,

длительность торгов, сезон года и т. д. Под ? следует понимать количе-

количество покупок в день (оно изменяется случайным образом от одного дня

к другому), а также выбор покупателями тех или иных товаров (спрос

на те или иные товары колеблется во времени).

*Чипиинель. Поскольку факторы ? случайные, то должен быть случай-

случайной величиной и показатель эффективности W. Не так ли?

Пвтор. Совершенно верно.

*Чипиинель. А как можно максимизировать случайную величину? И

возможно ли такое в принципе?

Пвтор. Очевидно, что такое невозможно. Какое бы решение х мы ни

выбрали, величина W все равно остается случайной, а потому нельзя

гарантировать, что она окажется максимальной.

'ЧеаЯаЯе**. Какой же в таком случае смысл заниматься поиском оп-

оптимального решения? Да и какое решение надо теперь считать опти-

оптимальным?

Пвтор. В условиях неопределенности мы действительно не можем со

стопроцентной гарантией сделать показатель эффективности максималь-

максимальным (или минимальным). Однако за счет соответствующего выбора ре-

решения мы можем добиться этого с достаточно большой вероятностью.

"ЧитОФнел^. Значит, существуют все-таки приемы, используемые при

принятии разумных решений в условиях неопределенности?

Пвтор. Существуют. Самый простой прием состоит в замене случай-

случайных величин их средними значениями. Тем самым мы переводим факторы ?

в группу факторов а и фактически заменяем выбор решения в условиях

неопределенности выбором решения в детерминированном случае.

*Чи(*иипель. Как это могло бы выглядеть в примере с распродажей

товаров?

Пвтор. В этом случае следовало бы исходить из того, что ежеднев-

ежедневно делается такое-то число покупок и спрос на такие-то товары со-

составляет ежедневно такие-то проценты от общего спроса. Короче го-

говоря, колебания спроса и самого числа покупателей в течение всего

31

времени распродажи попросту игнорируются. Уместно заметить, что

такой прием широко используется в физических задачах. Ведь почти все

величины в таких задачах (температура, давление, электрическое со-

сопротивление и напряжение, сила тока, освещенность и т. д.) являются,

строго говоря, случайными величинами. Решая задачи, мы не учиты-

учитываем случайных изменений величин, обусловленных случайностями в

поведении элементарных частиц вещества и света, поскольку эти изме-

изменения незначительны по сравнению со средними значениями величин.

Случайные изменения силы тока, напряжения, сопротивления являют-

являются всего лишь очень малыми флуктуациями и в задачах не учитываются.

Мы используем известный закон Ома /= U/ R, не принимая во внима-

внимание флуктуации силы тока /, напряжения Е/, сопротивления R.

'ЧиФнатель. По-видимому, прием, состоящий в замене случайных ве-

величин их средними значениями, не будет удовлетворительно работать,

если отклонения случайных величин от средних значений (иначе гово-

говоря, флуктуации случайных величин) будут существенны? Полагаю, что

в примере с распродажей товаров мы имеем дело именно с таким слу-

случаем. Количество покупателей и спрос на те или иные товары могут

заметно флуктуировать во время распродажи.

Пвтор. Тут Вы правы. Отмеченные Вами факторы выступают как

существенно случайные факторы. Такое, кстати говоря, встречается и в

физических задачах. Например, при рассмотрении шумов в электрон-

электронной аппаратуре принципиально нельзя пренебрегать случайностями в

поведении электронных потоков.

ёЧи<9ии9се*ь. Как надо действовать тогда, когда замена случайных ве-

величин их средними значениями недопустима?

Пвтор. В таких случаях нередко используется прием, называемый

оптимизацией в среднем. Он состоит в том, чтобы в качестве показателя

эффективности рассматривать не саму случайную величину W, а ее ма-

математическое ожидание (W), и пытаться максимизировать (минимизи-

(минимизировать) именно (W). Напомним, что в примерах, приведенных в § 1.1,

имелся в виду именно этот прием. Там предполагалось минимизиро-

минимизировать не само время завершения стройки, а среднее ожидаемое время ее

завершения, не просто расходы на контроль качества изделий, а средние

ожидаемые расходы. Предполагалось максимизировать не доход от рас-

распродажи товаров, а средний ожидаемый доход от этой распродажи.

g4utftiuSU*b. Можно ли считать, что оптимизация в среднем устраняет

неопределенность?

Пвтор. Нет, так считать нельзя. Неопределенность, конечно, сохра-

сохраняется. Эффективность того или иного решения, выбранного при ис-

32

пользовании оптимизации в среднем, может весьма сильно отличаться

от ожидаемой эффективности. Однако мы можем надеяться, что после

многих повторений операции в итоге обязательно будем иметь выиг-

выигрыш. Дело в том, что оптимизация в среднем используется тогда, когда

выигрыши при повторении операции суммируются, так что «минусы» в

одних случаях могут компенсироваться «плюсами» в других. Так, опти-

оптимизация в среднем оправдана, когда стремятся повысить прибыль от

распродажи товаров. Прибыли, получаемые в разные дни, суммируют-

суммируются, так что случайно возникающие «неудачные» дни могут быть ском-

скомпенсированы случайно возникшими «удачными» днями.

*Чи4п<ипель. Но, однако, не всегда такая компенсация возможна! Пред-

Предположим, рассматривается эффективность работы службы неотложной

медицинской помощи большого города. В качестве показателя эффек-

эффективности выберем время ожидания врача по вызову. Это время жела-

желательно минимизировать. Очевидно, что в данном случае нельзя исполь-

использовать оптимизацию в среднем. Ведь слишком долгое ожидание врача

одним больным отнюдь не компенсируется быстрым обслуживанием

другого больного.

Пвтор. Вы правы. В подобных случаях выдвигают дополнительное

требование (ограничение). Пусть время ожидания врача Wне должно

превышать некоторого значения Wo. Поскольку Wслучайная величина,

то нельзя просто потребовать выполнения неравенства W<W$. Но мож-

можно потребовать, чтобы это неравенство выполнялось с достаточно боль-

большой вероятностью, например с вероятностью 0,9. Учет этого требова-

требования означает, что из множества X должны быть изъяты те решения х,

для которых рассматриваемое требование не удовлетворяется. Подоб-

Подобные требования называют стохастическими ограничениями (или, иными

словами, вероятностными ограничениями). Понятно, что использование

таких ограничений заметно усложняет проблему принятия решения.

'Чипиинель. Я вижу, что отыскивать разумные решения в условиях

неопределенности в принципе возможно. Хотелось бы теперь более кон-

конкретно познакомиться с тем, как это делается на практике.

Пвтор. Именно этим мы теперь и займемся. Сначала мы познако-

познакомимся со специальным типом случайных процессов, довольно часто

встречающихся на практике, — т. н. марковскими случайными процесса-

процессами с дискретными состояниями. Затем мы поговорим о системах массо-

массового обслуживания и о теории игр (игровых методах обоснования реше-

решения). Завершая знакомство с «исследованием операций», мы рассмотрим

моделирование операций методом статистических испытаний, извест-

известным как метод Монте-Карло.

33

ЗАДАНИЯ ПО ТЕМЕ 1

1. В примере 2 в § 1.1 операция имеет один показатель эффективности. Укажите

возможные дополнительные показатели эффективности для данной операции.

2. Такое же задание по отношению к операциям, представленным в примерах 1,

Зи4в §1.1.

3. Попробуйте самостоятельно сформулировать одну или более конкретных опера-

операций и укажите для каждой операции несколько возможных показателей эффек-

эффективности.

4. Рассмотрите внимательно рис. 2 в таблице 1 и укажите, какими решениями вы-

вытесняются (доминируются) следующие решения: а) 12, б) 15, в) 4, г) 16, д) 1,

е) 18.

Ответы: а) 2 и 6; б) 2, 6 и 9; в) 6, 11 и 9; г) 13; д) 13, 2, 12 и 6; е) 2, 15, 6, 9

и 11.

5. Для двухкритериальной ситуации, представленной на рис. 5 в таблице 1, выбери-

выберите окончательное решение: а) учитывая ограничение по показателю И/2, б) ис-

используя метод последовательных уступок и считая при этом, что показатель

И/± важнее, чем И/2.

Ответы: а) 9, б) 7.

6. Такое же задание для ситуации, представленной на рис. 6 в таблице 1.

Ответы: а) 2, б) 2.

7. Такое же задание для ситуации, представленной на рис. 7 в таблице 1.

Ответы: а) 9, б) 10.

8. Используя схему на рис. 1 в таблице 2, подсчитайте в принятых здесь условных

единицах стоимость сооружения пути от пункта а до пункта со при выборе следую-

следующих решений (следующих возможных путей):

а) а - G± - F2 - Е3 - D4 - С4 - В3 - А2 - со;

б) a-G2-F3-E4-D4-C3-e2-/\1-co;

в) a- G±- F±- Е2- D3- С3- В3- А2- со;

г) а - G2 - F2 - Е3 - D3 - С3 - В2 - А2 - со.

Ответы: а) 85 единиц, б) 86 единиц, в) 84 единицы, г) 86 единиц.

9. Приступив к сооружению дороги от а до со (см. таблицу 2), руководитель строи-

строительства, не будучи знаком с динамическим программированием, избрал метод

простой пошаговой оптимизации. Он успел соорудить два отрезка пути, после

чего его заменили другим руководителем (который был знаком с динамическим

программированием) и предложили ему завершить сооружение дороги. Во сколько

в итоге обошлось государству строительство дороги от а до со?

Ответ: 77 единиц.

10. Во сколько бы обошлось государству строительство дороги от а до со, если бы

замена руководителя в предыдущей задаче произошла после сооружения не двух,

а трех отрезков пути?

Ответ: 83 единицы.

34

11. Начав сооружение дороги от а до со (см. таблицу 2), руководитель применил ди-

динамическое программирование, но успел соорудить лишь два отрезка пути, пос-

после чего был отправлен на повышение. Дорогу достраивал новый руководитель,

который о динамическом программировании даже не слышал и действовал по-

попросту — по методу простой пошаговой оптимизации. Во сколько в итоге обо-

обошлось государству сооружение дороги от а до со?

Ответ: 81 единица.

12. После того, как в процессе сооружения дороги от а до со (см. таблицу 2) строители

оказались в пункте D4, явился руководитель, знакомый с динамическим програм-

программированием, который и достроил дорогу. Во сколько обошлось государству соору-

сооружение дороги от а до со: а) в наилучшем возможном случае, б) в наихудшем случае

(когда строительство от а до D4 велось по наиболее дорогостоящему варианту)?

Ответы: аO8 единиц, б) 83 единицы.

13. Предложите одну или более ситуаций с выбором решения в условиях неопреде-

неопределенности, когда оптимизацию в среднем применять не следует, а надо ввести

стохастическое ограничение.

35

ТЕМА 2

ИССЛЕДОВАНИЕ ОПЕРАЦИЙ:

МОДЕЛИРОВАНИЕ ОПЕРАЦИЙ ПО СХЕМЕ

МАРКОВСКИХ СЛУЧАЙНЫХ ПРОЦЕССОВ

Многие операции, которые приходится

анализировать под углом зрения выбора оп-

оптимального решения, развиваются как слу-

случайные процессы, ход и исход которых за-

зависят от ряда случайных факторов... Для

математического описания многих операций,

развивающихся в форме случайного процес-

процесса, может быть с успехом применен матема-

математический аппарат, разработанный в теории

вероятностей для так называемых марковс-

марковских случайных процессов.

Е. С. Вентцелъ

Справка. Андрей Андреевич Марков A856-1922) — выдающийся российский мате-

математик, один из учеников П.Л. Чебышева A821-1894). Понятие «цепи Маркова» ока-

оказалось весьма ценным в различных приложениях, например, в теории диффузии,

теории массового обслуживания, теории надежности, а также в квантовой механике

и генетике. Развитие идеи марковской цепи привело к созданию важного раздела

теории вероятностей — теории случайных процессов, в которой исключительную роль

сыграли труды АК Колмогорова A903-1987) и А.Я. Хинчина A894-1959).

36

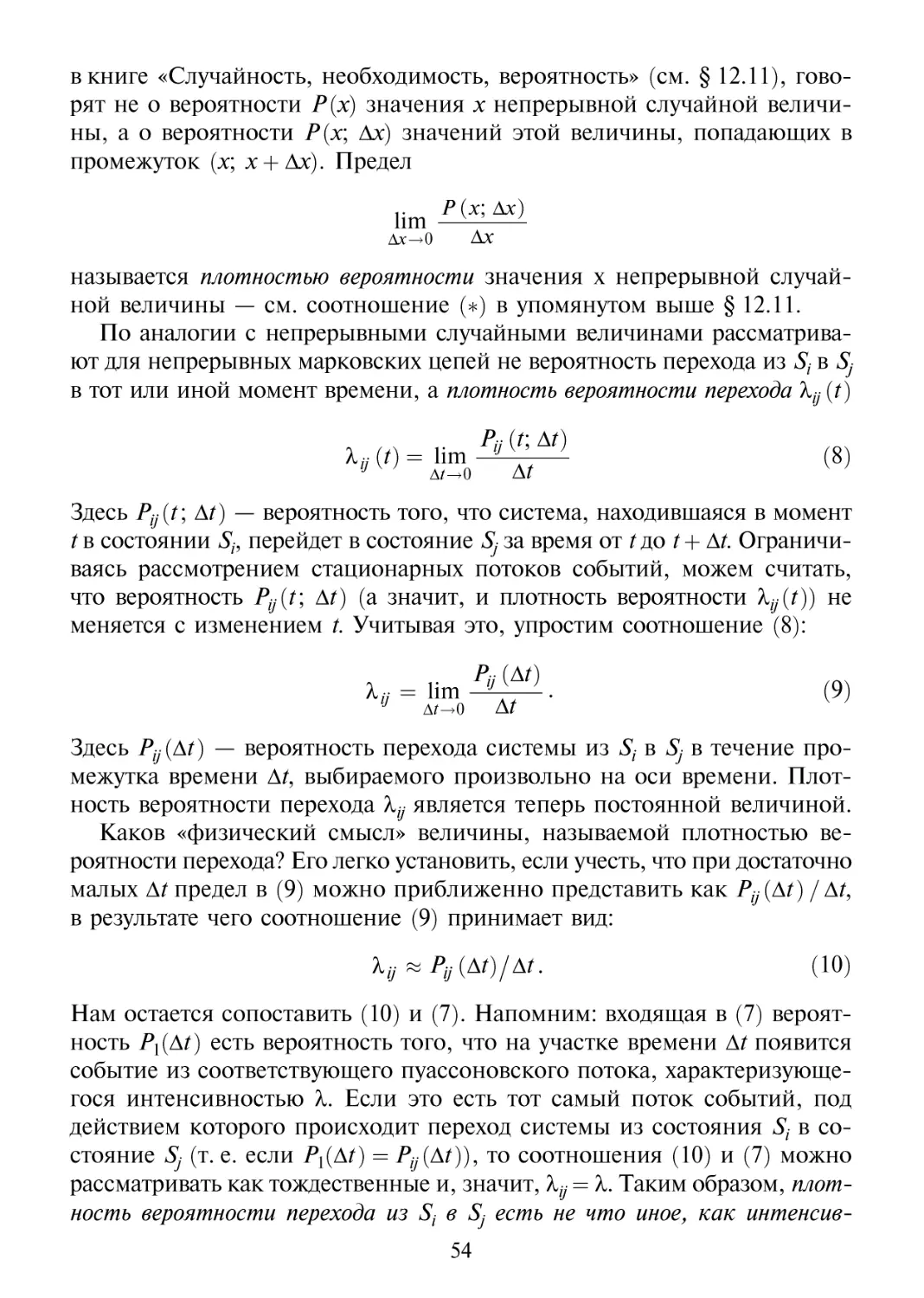

2.1 Марковские случайные процессы

с дискретными состояниями и графы

в

книге «Случайность, необходимость, вероятность» тема 11 была у

нас посвящена испытаниям Бернулли — независимым испытаниям с

двумя исходами, образующими полную группу событий («успех» и «не-

«неудача»). Независимые испытания Бернулли можно рассматривать как

частный случай цепей Маркова. Последние представляют собой последо-

последовательность испытаний, в каждом из которых появляется одно не из двух,

аизп образующих полную группу несовместных событий AhA2,A3,..., АП9

причем испытания теперь не являются полностью независимыми, а свя-

связаны между собой в определенного рода цепь. Конкретно: вероятность

наступления того или иного события Аъ А2,...9 Ап при очередном испы-

испытании (пусть это будет k-ot испытание) зависит от результата предыду-

предыдущего испытания (результата (k-l)-ro испытания) и только от него. Упо-

Упомянутая вероятность не зависит от результатов более ранних испытаний:

(?-2)-го, (?-3)-го, (?-4)-го и др.

Рассмотрим терминологию, которая обычно используется при изло-

изложении цепей Маркова. Упомянутым выше п независимым событиям

Аь А2,..., Ап сопоставляют п состояний Sh S2, S$,..., Sn, в одном из кото-

которых находится в данный момент времени некоторая система. Итак, пусть

Sh S2, S3,...9 Sn — возможные дискретные состояния некоторой систе-

системы. В любой момент времени система находится в каком-то из этих

состояний. В некий момент может произойти изменение состояния сис-

системы, после чего система окажется в каком-то другом из возможных

состояний. Таким образом, событие теперь — это нахождение системы в

соответствующем состоянии, а испытание связывается с изменением со-

состояния. Если состояние системы меняется во времени случайным обра-

образом, то говорят, что в системе протекает случайный процесс, в связи с чем

цепь Маркова называют также марковским случайным процессом. Точнее

говоря, марковским случайным процессом с дискретными состояниями.

Специфика марковского случайного процесса состоит в том, что веро-

вероятность системе оказаться (в результате очередного изменения состояния,

т. е. при очередном испытании) в некотором состоянии Sj зависит только

от того, в каком состоянии St она (система) находилась непосредственно

перед данным испытанием, и не зависит от того, когда и каким образом

система пришла в состояние Si9 т. е. в каких состояниях она побывала

ранее. Таким образом, марковский случайный процесс можно определить

как случайный процесс, в котором для каждого момента времени t0 вероятность

того или иного состояния системы в будущем (т. е. при t > /q) зависит от ее

состояния в настоящем (при t=t0) и не зависит от развития процесса в

37

прошлом {при t<t0). Иногда это свойство системы называют отутствием у

нее долговременной «памяти»; система запоминает только свое последнее

состояние, но напрочь «забывает» о всех более ранних.

В общем случае состояния системы могут меняться непрерывным

образом, плавно. Так, процесс изменения напряжения в электросети

является случайным процессом с непрерывными состояниями. Но мы

ограничимся рассмотрением процессов с дискретными состояниями —

когда возможные состояния системы (Sh Sb S3,...) можно перенумеро-

перенумеровать одно за другим. При этом сам процесс состоит в том, что время от

времени система скачком (мгновенно) переходит (можно сказать: пере-