Текст

Ч. ЛОУСОН, Р. ХЕНСОН

ЧИСЛЕННОЕ

РЕШЕНИЕ

ЗАДАЧ

МЕТОДА

НАИМЕНЬШИХ

КВАДРАТОВ

Перевод с английского Х.Д. Икрамова

МОСКВА ’’НАУКА”

ГЛАВНАЯ РЕДАКЦИЯ

ФИЗИКО-МАТЕМАТИЧЕСКОЙ ЛИТЕРАТУРЫ

19 8 6

ББК 22.19

Л 81

УДК 519.6

Charles L. Lawson

Richard J. Hanson

Prentice-Hall, Inc.

Solving Least Squares Problems

Englewood Cliffs, New Jersey

Лоусон Ч., Хенсон P. Численное решение задач метода наименьших

квадратов/Пер. с англ. — М.: Наука. Гл. ред. физ.-мат. лит., 1986. — 232 с.

Книга посвящена изложению численных решений линейных задач метода наимень¬

ших квадратов. Достоинством книги являются: отбор наиболее устойчивых методов,

полный анализ устойчивости, рассмотрение среднеквадратичных задач с линейными

ограничениями, обзор методов перестройки ортогональных разложений при добавле¬

нии или удалении одного или нескольких наблюдений.

Для специалистов по прикладной математике, инженеров, а также для студентов

и аспирантов.

Рецензент доктор физико-математических наук В.Н. Кублановская

©Prentice-Hall, Inc., Englewood

Cliffs, N.J., 1974

© Издательство "Наука”,

Главная редакция

физико-математической

литературы,

перевод на русский язык,

предисловие и послесловие

переводчика, 1986

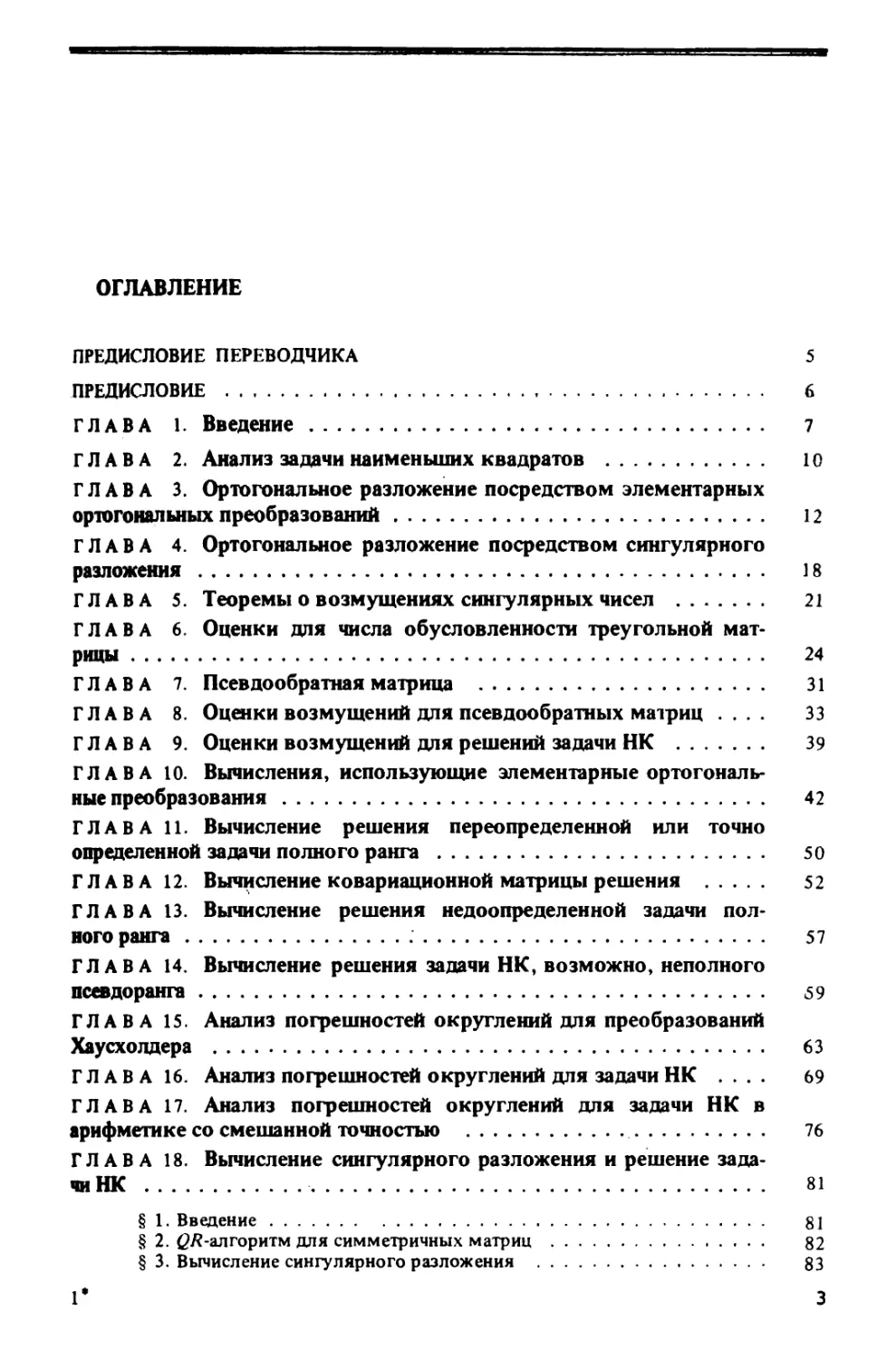

ОГЛАВЛЕНИЕ

ПРЕДИСЛОВИЕ ПЕРЕВОДЧИКА 5

ПРЕДИСЛОВИЕ 6

ГЛАВА 1. Введение 7

ГЛАВА 2. Анализ задачи наименьших квадратов 10

ГЛАВА 3. Ортогональное разложение посредством элементарных

ортогональных преобразований 12

ГЛАВА 4. Ортогональное разложение посредством сингулярного

разложения 18

ГЛАВА 5. Теоремы о возмущениях сингулярных чисел 21

ГЛАВА 6. Оценки для числа обусловленности треугольной мат¬

рицы 24

ГЛАВА 7. Псевдообратная матрица 31

ГЛАВА 8. Оценки возмущений для псевдообратных матриц .... 33

ГЛАВА 9. Оценки возмущений для решений задачи НК 39

ГЛАВА 10. Вычисления, использующие элементарные ортогональ¬

ные преобразования 42

ГЛАВА 11. Вычисление решения переопределенной или точно

определенной задачи полного ранга 50

ГЛАВА 12. Вычисление ковариационной матрицы решения 52

ГЛАВА 13. Вычисление решения недоопределенной задачи пол¬

ного ранга 57

ГЛАВА 14. Вычисление решения задачи НК, возможно, неполного

псевдоранга 59

ГЛАВА 15. Анализ погрешностей округлений для преобразований

Хаусхолдера 63

ГЛАВА 16. Анализ погрешностей округлений для задачи НК .... 69

ГЛАВА 17. Анализ погрешностей округлений для задачи НК в

арифметике со смешанной точностью 76

ГЛАВА 18. Вычисление сингулярного разложения и решение зада¬

чи НК 81

§ 1. Введение 81

§ 2. (?/?-алгоритм для симметричных матриц 82

§ 3. Вычисление сингулярного разложения 83

1* 3

§ 4. Решение задачи НК посредством сингулярного разложения .... 90

§ 5. Организация программы, вычисляющей сингулярное разложение 91

ГЛАВА 19. Другие методы для задачи наименьших квадратов ... 92

§ 1. Нормальные уравнения и разложение Холесского 93

§ 2. Модифицированная ортогонализаиия Грама-Шмидта 99

ГЛАВА 20. Линейные задачи наименьших квадратов с линейными

ограничениями-равенствами: решение с помощью базиса нуль-прост-

ранства 103

ГЛАВА 21. Линейные задачи наименьших квадратов с линейными

ограничениями-равенствами: решение посредством прямого исклю¬

чения 111

ГЛАВА 22. Линейные задачи наименьших квадратов с линейными

ограничениями-равенствами: решение путем взвешивания 114

ГЛАВА 23. Линейные задачи наименьших квадратов с линейными

ограничениями-неравенствами 122

§ 1. Введение 122

§ 2. Характеризация решения 123

§ 3. Задача NNLS 124

§ 4. Задача LDP 127

§ 5. Преобразование задачи НКН в задачу LDP 129

§ 6. Задача НКН с ограничениями-уравнениями 130

§ 7. Пример выравнивания при наличии ограничений 131

ГЛАВА 24. Модификация QR-разложения матрицы при добавле¬

нии или удалении столбцов 134

ГЛАВА 25. Практический анализ задач метода наименьших квад¬

ратов 137

§ 1. Общие соображения 137

§ 2. Левое умножение А и Ъ на матрицу G ^ . 140

§ 3. Правое умножение А на матрицу Н и замена переменных л* = Нх + £ 141

§ 4. Приписывание дополнительных строк к [А : Ь) 144

§ 5. Удаление переменных 149

§ 6. Сингулярный анализ 151

ГЛАВА 26. Примеры некоторых методов анализа задачи наимень¬

ших квадратов 153

глава 27. Модификация QR-разложения при добавлении или

удалении строки (с приложениями к последовательной обработке

задач с большими или ленточными матрицами коэффициентов) . . , . 160

§ 1. Последовательное накапливание 161

§ 2. Последовательное накапливание ленточных матриц 164

§ 3. Пример: линейные сплайны 169

§ 4. Сглаживание посредством кубических сплайнов 172

§ 5. Удаление строк 174

ПРИЛОЖЕНИЕ А. ОСНОВЫ ЛИНЕЙНОЙ АЛГЕБРЫ 180

ПРИЛОЖЕНИЕ В. ДОКАЗАТЕЛЬСТВО ГЛОБАЛЬНОЙ КВАДРАТИЧНОЙ

СХОДИМОСТИ ^ АЛГОРИТМА 186

ПОСЛЕСЛОВИЕ. Х.Д. ИКРАМОВ 194

СПИСОК ЛИТЕРАТУРЫ 219

СПИСОК ЛИТЕРАТУРЫ, ДОБАВЛЕННЫЙ ПРИ ПЕРЕВОДЕ 226

4

ПРЕДИСЛОВИЕ ПЕРЕВОДЧИКА

Опубликованная в 1974 г. книга Ч. Лоусона и Р. Хенсона имела двоякое назначе¬

ние. С одной стороны» она задумана как учебник по прямым методам решения линей¬

ных среднеквадратичных задач - для лиц, не знакомых с основами вычислительной

алгебры, и как справочник - для тех, кто имеет опыт работы в этой области. С другой

стороны, в книге содержались тексты фортранных подпрограмм описанных в ней ме¬

тодов.

Через 12 лет после выхода книги можно констатировать, что она полностью сохра¬

нила свое значение учебника-справочника, все еще единственного по данному пред¬

мету. В советской монографической литературе методы численного решения задач

наименьших квадратов обойдены вниманием. Исключением являются лишь отдельные

главы книг В.В. Воеводина, например "Вычислительные основы линейной алгебры”

(М.: Наука, 1977). Можно надеяться поэтому, что перевод данной книги, дополненный

небольшим послесловием- комментарием к литературе последнего десятилетия,

будет полезен советским читателям. В то же время было решено отказаться от публи¬

кации текстов программ по следующим соображениям. Для наиболее содержательного

и сложного метода - алгоритма сингулярного разложения - хорошая программа на

фортране имеется в книге [ 12*]. Программы прочих методов легко получить компи¬

ляцией обычных алгебраических процедур: ортогонально-треугольного разложения

матрицы, решения треугольной системы и т.п. Соответствующие стандартные подпро¬

граммы можно найти в любой сколько-нибудь развитой библиотеке прикладного ма¬

тематического обеспечения.

Книга в основном посвящена задачам с заполненными матрицами, размеры т, п

которых удовлетворяют условию тп < Mt где М - оперативная память используе¬

мой ЭВМ. Для многих современных машин М составляет величину порядка несколь¬

ких мегаслов, и методы, изложенные в книге, позволяют решать достаточно большие

задачи. Но для сверхбольших задач с сильной разреженностью условие тп < М оказы¬

вается обременительным, а хранение матрицы полным массивом - излишним. Из раз¬

реженных задач в книге рассматривается лишь специальная ситуация ленточных мат¬

риц. Более полная картина разреженного случая дана в обзоре [ 3 * ].

При переводе сохранена непривычная для советского читателя сквозная нумерация

формул, утверждений и определений.

Я хотел бы поблагодарить Д.С. Шмерлинга и В.Ф. Матвеева за помощь в переводе

терминов регрессионного анализа.

ХМ. Икрамов

ПРЕДИСЛОВИЕ

В этой книге собрана информация о задачах метода наименьших квадра¬

тов и практичных алгоритмах их решения, разработанных главным образом

в течение последнего десятилетия. Эта информация будет полезна научно¬

му работнику, инженеру или студенту, связанным в своей работе с анали¬

зом и решением систем линейных алгебраических уравнений. Такая система

может быть определена, переопределена или недоопределена; она может

быть совместна или несовместна. Она может сопровождаться ограничения¬

ми в форме линейных уравнений или неравенств.

Специалисты конкретных областей разработали методы и терминологию

для задач наименьших квадратов из своих дисциплин. Материал, представ¬

ленный в нашей книге, может помочь в преодолении этой разобщенности

и достижении методологического и терминологического единства.

По существу, все реальные задачи нелинейны. Многие методы анализа

нелинейных задач или вычислений на основе нелинейных моделей включают

в себя процедуру локальной замены нелинейной задачи линейной. В част¬

ности, различные методы анализа и решения нелинейных задач метода

наименьших квадратов предполагают решение последовательности линей¬

ных задач. Важное требование этих методов — умение вычислять такие

решения линейных задач наименьших квадратов (возможно, плохо обус¬

ловленных), которые были бы приемлемы в контексте нелинейной задачи.

Читателю, интересующемуся в первую очередь практическими приложе¬

ниями, мы рекомендуем начать чтение книги с гл. 25.

Начиная с Гаусса, многие математики участвовали в теоретической и

практической разработке техники решения задач метода наименьших

квадратов. Мы хотим особенно выделить вклад профессора Дж. Голуба,

которому в этой области принадлежит много важных идей и алгоритмов.

Первый из авторов познакомил второго с задачей наименьших квадратов

в 1966 г. С тех пор авторы тесно сотрудничали в JPL*), адаптируя устой¬

чивые математические методы к практическим вычислительным задачам.

Данная книга является частью этой совместной работы.

Ч.Л, Лоусон

Р.Дж. Хенсон

*)jPL - Jet Propulsion Laboratory - Лаборатория реактивного движения. (Примеч.

пер.)

6

ГЛАВА 1

ВВЕДЕНИЕ

Эта книга задумана одновременно как учебник и как справочник для

лиц, которым приходится решать линейные задачи теории наименьших

квадратов. Такие задачи часто возникают как составная часть некоторой

более обширной вычислительной проблемы. Например, определение орби¬

ты космического корабля нередко сводится математиками к решению

многоточечной краевой задачи для обыкновенного дифференциального

уравнения. При этом вычисление орбитальных параметров обычно требует

нелинейного оценивания в смысле наименьших квадратов; в последнем

используют различные схемы линеаризации.

Более общо, почти любая задача, в которой исходных данных достаточно

для того, чтобы переопределить решение, требует применения того или

иного метода аппроксимаций. Наиболее часто в качестве критерия аппрок¬

симации выбирают метод наименьших квадратов.

При расчетах по методу наименьших квадратов часто встречаются допол¬

нительные ограничения. Их стоит определить более точно, чтобы облегчить

последующее построение алгоритмов. Опишем несколько примеров.

Задача может быть связана с некоторыми соотношениями равенства

или неравенства между переменными. Она может требовать обработки

столь большого объема информации, что главной проблемой становится

распределение машинной памяти.

Во многих случаях цель вычислений по методу наименьших квадратов

не исчерпывается тем, чтобы найти некоторый набор чисел, который ’’ре¬

шает” задачу. Скорее, исследователь желает получить добавочную количест¬

венную информацию, описывающую связь решения с исходными данными.

В частности, задача может допускать целое семейство различных решений,

которые почти в равной степени удовлетворяют поставленным условиям.

Исследователь может пожелать описать эту неопределенность и затем

произвести выбор в указанном семействе в соответствии с некоторыми

дополнительными требованиями.

В этой книге представлены численные методы решения задач теории

наименьших квадратов, учитывающие высказанные выше положения.

Эти методы успешно использовались большим коллективом инженеров

и научных сотрудников, включающим авторов, в ходе выполнения про¬

граммы NASA непилотируемых космических полетов.

Задача наименьших квадратов, которую мы здесь рассматриваем,

в разных научных дисциплинах называется по-разному. Например, мате¬

матики могут подойти к ней как к задаче отыскания для заданной точки

7

функционального пространства ближайшей точки в заданном подпрост¬

ранстве. Специалисты по численному анализу тоже нередко использовали

этот подход, при котором в тени остается вопрос об ошибках входной

информации. Вследствие этого теряется возможность извлечь выгоду из

произвола, часто присутствующего в решении.

Статистики вводят в свою постановку задачи вероятностные распреде¬

ления и используют для описания этой области термины ттъ регрессион¬

ный анализ. Инженеры приходят к этой задаче, занимаясь такими предме¬

тами, как оценивание параметров или фильтрация.

Главное состоит в следующем: когда эти задачи (сформулированные

в любом из названных контекстов) достигают стадии конкретных расче¬

тов, они содержат в себе одну и ту же центральную проблему, а именно

последовательность линейных задач наименьших квадратов.

Эту основную линейную задачу наименьших квадратов (НК) можно

сформулировать следующим образом:

Задача НК. Пусть даны действительная m X п-матрица А ранга к <

<min(m, ri) и действительный m-вектор Ь. Найти действительный п-век-

тор х0, минимизирующий евклидову длину вектора Ах — Ь.

(В приложении А читатель может найти определения незнакомых ему

терминов линейной алгебры.) Для обозначения задачи НК мы будем ис¬

пользовать символику Ах = Ь.

1 а ^b

/77-/7 •

/77-/7 •

Ах*Ь

rank А -/77-/7

2 а

Ах~Ь

rank А - ккгпшп

г ь

m >п

Ах*Ь

rank А - п «/77

За

АхшЬ

rank А - А </7 </77

3 b

Ах-Ь

Аш m <п

Ах *Ь

rank A-k<m<n

Рис. 1.1. Шесть случаев задачи НК в соответствии со сравнительной величиной т, ян

ранга А

8

Эту задачу можно поставить и исследовать также и для комплексных А

и Ь. Комплексный случай встречается на практике гораздо реже, чем дейст¬

вительный. В то же время теория и численные методы для действительного

случая непосредственно переносятся на комплексный.

Помимо приведенной формулировки задачи НК (в данном контексте)

есть еще дополнительное условие: числовые данные, составляющие А и Ьу

имеют лишь конечное число верных разрядов; последующие разряды

совершенно не определены ы, следовательно, произвольны. Это обычное

для практики положение дел. Оно связано, в частности, с ограниченной

точностью измерений или наблюдений. Важно в должной мере учесть эту

ситуацию и с выгодой использовать ее для получения подходящего прибли¬

женного решения задачи. Мы будем обсуждать методы, позволяющие

достигнуть этого, в особенности в гл. 25, 26.

Рассмотрим в качестве важного примера случай, когда линейная задача

наименьших квадратов происходит из нелинейной и вектор решения jc0

должен использоваться как поправка, прибавляемая к текущему номи¬

нальному решению нелинейной задачи. Линеаризованная задача будет

полезным приближением к нелинейной лишь в некоторой ограниченной

окрестности. Если имеются различные векторы, дающие достаточно малые

невязки в линейной задаче, то можно предпочесть тот, что имеет наимень-

шую длину. Это увеличивает вероятность остаться в окрестности, где

разумно линейное приближение.

Следующие три положения лежат в основе нашего подхода к методу

наименьших квадратов:

1. Поскольку исходные данные задачи НК не вполне определенны, мы

можем изменить их, приспособив к своим нуждам.

2. Мы будем применять ортогональные матрицы исключения непосредст¬

венно к линейной системе задачи НК.

3. Всюду большое внимание уделяется практичности при машинной реа¬

лизации.

Дадим краткий комментарий к первым двум положениям. Наша цель

при изменении задачи, о котором говорится в п. 1, состоит в том, чтобы

избежать ситуации (см. выше), когда ’’малое” изменение исходных данных

приводит к ’’большим” изменениям решения.

Матрицы ортогональных преобразований, упомянутые в п. 2, находят

естественное место в методе наименьших квадратов, поскольку они

оставляют неизменной евклидову длину вектора. Кроме того, их исполь¬

зование желательно и вследствие присущей им численной устойчивости

по отношению к распространению ошибок или неопределенности входных

данных.

Мы не выдвигали никаких предположений относительно сравнительной

величины параметров тип. Для последующего обсуждения задачи НК

удобно разделить шесть случаев, иллюстрируемых на рис. 1.1.

Наибольшее внимание в этой книге будет направлено на случай 2а;

при этом специально будет рассмотрена ситуация, когда неопределенность

во входных данных приводит к случаю 2Ъ. Однако алгоритмы и их обсуж¬

дение будут даны для всех шести случаев.

9

ГЛАВА 2

АНАЛИЗ ЗАДАЧИ НАИМЕНЬШИХ КВАДРАТОВ

Основным содержанием этой главы будет анализ задачи НК, основанный

на представлении т X л-метрицы А произведением вида HRK Т, где Н и К -

ортогональные матрицы. Определения ортогональной матрицы и других

понятий линейной алгебры приведены в приложении А.

Наш интерес к разложению А = HRK т общего вида мотивирован прак¬

тичностью и полезностью некоторых конкретных вычислимых разложений

этого типа, которые будут введены в гл. 3,4.

Важным свойством ортогональных матриц является сохранение евкли¬

довой длины при умножении. Это значит, что для любого ди-вектора у и

любой ортогональной m X w-матрицы Q

В контексте задачи НК, где речь идет о минимизации евклидовой длины

вектора Ах - Ь, имеем

для произвольной ортогональной m X m-матрицы Q и любого л-вектора х.

Использование ортогональных преобразований позволяет выразить

решение задачи НК следующим образом:

Теорема 2.3. Пусть А - тХ п-матрица ранга к, представленная в виде

где Н - ортогональная m X m-матрица \ R - тХ п-матрица вида R =

Г Rn 01

= ; Лп -кХк-матрица ранга к\ К - ортогональная пХп-мат-

[ 0 0 J

рица. Определим вектор

WQy II = \\у II.

(2.1)

\\Q{Ax-b)\\ = || QAx - Qb || = \\Ax-b\\

(2.2)

А = HRK т,

(2.4)

(2.5)

и введем новую переменную

(2.6)

Определим у \ как единственное решение системы

КиУ 1 =£i-

Тогда:

1) Все решения задачи о минимизации || Ах - b || имеют вид

(2.7)

(2.8)

10

2) Любой такой вектор х приводит к одному и тому же вектору

невязки г:

г = Ь-Ах=Н | ° | . (2.9)

3) Для нормы г справедливо

||г|| = \\Ь-Ах\\ = ||*2 ||. (2.10)

4) Единственным решением минимальной длины является вектор

Чо]

(2.11)

Доказательство. Заменяя А правой частью равенства (2.4) и при¬

меняя (2.2), получаем

\\Ах-Ь\\2 = \\HRKTx - Ь\\2 = \\RKTx-HTb II2. (2.12)

Из уравнений (2.5) —(2.8) следует, что

ЦАх-ЬП1 = ||Я, ,7i -gl ||г + \\g2\\2 (2.13)

для всех х.

Правая часть (2.13) имеет минимальное значение \\g2 II2, если

«ii.Fi =Si. (2.14)

Уравнение (2.14) допускает единственное решение у i, так как ранг Rlx

равен к.

Общее решение у выражается формулой

И

(2.15)

где у2 произвольно.

Для вектора х, определенного уравнением (2.8), имеем

_Л Г 0

Ъ- Ах = ъ - HRKTx=H(g - Ry)=H

L g2

что устанавливает равенство (2.9).

Ясно, что среди векторов у вида (2.15) наименьшую длину имеет тот,

для которого Уг = 0. Из (2.8) следует, что решением наименьшей евклидо¬

вой длины будет вектор

х=К

о 1 • <2,6)

Теорема 2.3 доказана.

Всякое разложение m X л-матрицыЛ того же типа, что и (2.4) , мы будем

называть ортогональным разложением А.

В случае к - п или к - m величины с размерностями соответственно п - к

или m — к отсутствуют. В частности, при к - п решение задачи НК единст¬

венно.

11

Заметим, что решение минимальной длины, множество всех решений и

минимальное значение для задачи минимизации || Ах - b || определяются

единственным образом. Они не зависят от конкретного ортогонального

разложения.

У пражнение

2.17. Пусть А - т X л-матрица (т > п) ранга к и QlRl = А = Q2R2. Если Qi -

т X л-матрицы с ортогональными столбцами, а /?,* - верхние треугольные л X л-матри¬

цы, то существует диагональная матрица D с диагональными элементами, равными

+ 1 или - 1, такая, что Q2D = Q^ и DRX = R2.

ГЛАВА 3

ОРТОГОНАЛЬНОЕ РАЗЛОЖЕНИЕ ПОСРЕДСТВОМ

ЭЛЕМЕНТАРНЫХ ОРТОГОНАЛЬНЫХ ПРЕОБРАЗОВАНИЙ

В гл. 2 показано, что задача НК может быть решена, если имеется орто¬

гональное разложение т X л-матрицы А В этой главе мы установим сущест¬

вование такого разложения для произвольной матрицы, используя явные

ортогональные преобразования.

Два типа элементарных ортогональных преобразований, которые нам

понадобятся, представлены в следующих двух леммах.

Лемма 3.1. Пусть дан (ненулевой) m-вектор v. Существует ортого¬

нальная матрица Q такая, что

Qv = -o\\v\\elf (3.2)

где

+ 1, если Vi > О,

- 1, если V\ <0,

a V\ ~ первая компонента вектора v.

Доказательство. Положим

иит

и =и +а и и 11*1, Q = —. (3.3)

и1 и

Доказательство завершается прямой проверкой симметричности и ортого¬

нальности матрицы Q из (3.3) и остающейся части утверждения леммы 3.1.

Преобразование, определяемое формулой (3.3), использовалось Хаус-

холдером [101] для решения некоторых задач на собственные значения.

По этой причине матрица Q и соответствующее преобразование называются

матрицей и преобразованием Хаусхолдера.

Это преобразование с геометрической точки зрения есть отражение в

тп - 1-мерном подпространстве S, ортогональном к вектору и. Это значит,

что Qu- - и и Qs = s для всех s Е S.

В специальном случае, когда нужно преобразовать к нулю только один

элемент вектора у, часто используют следующее преобразование Ги¬

12

венса [69]. Так как это преобразование изменяет только две компоненты

вектора, то достаточно изучить его действие на 2чвектор.

Лемма 3.4.Пусть дан 2-вектор v =(ui, v2)T, причем Ф 0либо v2 ФО.

Существует ортогональная 2 X 2-матрица

«■[.с, I] <з5>

такая, что

са +s2 = 1, (3.6)

Г (yi + vl)1 1

ft- о J ■ (3.4

Доказательство. Положим просто

С=(^!77Г’ (38)

,e(»?+uD1/2 ' (3'9)

Легко показать, что матрица G из (3.5) ортогональна и удовлетворяет

условию (3.7). Лемма 3.4 доказана.

Заметим еще, что G можно выбрать не только ортогональной, но и

симметричной, полагая

■[I -Я'

(ЗЛО)

с и s те же, что и в формулах (3.8), (3.9).

Теорема 3.11. Пусть А - тХ п-матрица. Существует ортогональная

m X m-матрица Q такая, что в матрице QA - R под главной диагональю

стоят только нулевые элементы.

Выберем ортогональную m X m-матрицу Q в соответствии с леммой 3.1

так, чтобы первый столбец QiA имел нулевые компоненты со 2-й по т-ю.

Далее выбираем ортогональную (т - 1) X (т - 1) -матрицу Р2 следующим

образом. Будучи применена к т - 1 вектору, составленному из компонент

со 2-й по тло второго столбца матрицы Q\A, она аннулирует компоненты

с 3-й по т-ю этого вектора. Матрица преобразования

1 О

■[:

л-i.

ортогональна, и Q7Q1A имеет в первых двух столбцах нули под главной

диагональю.

Продолжая таким образом, можно построить произведение, состоящее

самое большее из п ортогональных преобразований, которое трансформи¬

рует А к верхней треугольной форме. Эти рассуждения можно формали¬

зовать и получить доказательство теоремы 3.11 методом конечной ин¬

дукции.

Алгоритмические детали построения указанных преобразований будут

даны в гл. 10. Полученное представление матрицы произведением ортого¬

нальной и верхней треугольной матриц называется QR-разложением. Оно

13

играет важную роль в ряде вычислительных алгоритмов линейной алгеб¬

ры [59, 72].

Для случаев 1 а и 2а рис. 1.1, где rank Л = л, теорема (3.11) устанавли¬

вает существование ортогонального разложения А. Действительно, соглас¬

но теореме 3.11, можно написать

A =QTR =QTRIn; (3.12)

матрицы Q r, R, /„ этого представления имеют свойства, требуемые в соот¬

ветствии с теоремой (2.3) от сомножителей tf, R, К т ортогонального разло¬

жения матрицы А.

Если rank Л = m (см. За на рис. 1.1), то теорема 3.11 позволяет нам

написать

Ат = QTR, (3.13)

так что

A=RTQ =ImRTQ. (3.14)

В этом представлении Im,RT,Q имеют свойства, требуемые в соответствии

с теоремой 2.3 от сомножителей Н, R, Кт ортогонального разложения

матрицы ранга т.

Для случаев 1 Ь, 2Ь и 3b рис. 1.1 матрица R, полученная в теореме 3.11,

необязательно имеет форму, требуемую ортогональным разложением.

Мы переходим к обсуждению дополнительных преобразований, которые

позволяют получить ортогональное разложение и для этих случаев.

Теорема 3.15. Пусть А - m X п-матрица ранга ку причем к < п <т.

Существуют ортогональная m X m-матрица Q и п X п-матрица перестанов¬

ки Р такие, что

qapAI »]• (з,б)

где R - верхняя треугольная k X к-матрица ранга к.

Доказательство. Выберем матрицу перестановки Р таким обра¬

зом, чтобы первые к столбцов матрицы АР были линейно независимы.

Согласно теореме 3.11, найдется ортогональная m X гя-матрица Q такая, что

QAP — верхняя треугольная. Поскольку первые к столбцов АР линейно не¬

зависимы, это же будет верно для первых к столбцов QAP.

Все элементы матрицы QAP, стоящие на пересечении строк с номерами

А + 1, . . ., m и столбцов с номерами к + 1,.. ., л, будут нулями. В против¬

ном случае rank QAP > ку что противоречит предположению rank А = к.

Итак, QAP имеет форму, указанную правой частью (3.16). Теорема 3.15

доказана.

Подматрицу [R : Т] из правой части (3.16) можно теперь преобразовать

к компактной форме, требуемой от матрицы R из теоремы 2.3. Это преоб¬

разование описывает следующая лемма.

Лемма 3.17. Пусть [Л: Т] - к X п-матрица, причем R имеет ранг к.

Существует ортогональная п X п-матрица W такая, что

[Л:Г]И/=[Л:0], (3.18)

А

где R - нижняя треугольная матрица ранга к.

14

Лемма 3.17 вытекает из теоремы 3.15, если отождествить величины

п, к, [Л:Г], W из формулировки леммы с соответствующими величинами

т, п, АТ, QT теоремы3.15.

Используя лемму 3.17 вместе с теоремой 3.15, можно доказать следую¬

щую теорему.

Теорема 3.19. Пусть А - m X п-матрица ранга к. Найдутся ортого¬

нальная m X m-матрица Н и ортогональная п X п-матрица К такие, что

причем Ri г - невырожденная треугольная k X к-матрица.

Заметим, что выбором Н и К в уравнении (3.20) можно добиться, чтобы

Ri 1 в (3.21) была верхней или нижней треугольной.

Подведем итоги. Было показано, что существуют конструктивные про¬

цедуры для получения ортогональных разложений вида А = HRK т для всех

шести случаев, изображенных на рис. 1.1. Во всех случаях подматрица R \ i

ранга к из теоремы 2.3 будет получена в треугольной форме. Поэтому вы¬

числить решение уравнения (2.7) будет совсем просто.

Как уже отмечалось, в случаях 1а и 2а в качестве матрицы К т разложе¬

ния можно взять единичную матрицу /„. Точно так же в случае За в ка¬

честве Н можно взять единичную матрицу Im.

С целью иллюстрации этих ортогональных разложений мы приведем

численный пример для каждого из шести случаев рис. 1.1.

Случай 1а. Квадратная невырожденная матрица:

Н ТАК = R, A=HRKT,

(3.20)

где

R =

[

(3.21)

m=n= 3, rank А = 3, QA =R.

(3.22)

-0,4800 -0,4129 -0,7740

Q= 0,6616 -0,7498 - 0,0103 ,

— 5 1

л= 0,3515 0,9665

0,6590 0,9343 |

— 0,8514 - 1,1987

-0,5761 -0,5170 0,6331

0,4087 0,1593

R = 0,0 - 0,6289 - 0,0414 I

0,0 0,0 — 0,1304J

Случай 2a. Матрица переопределена и имеет полный ранг:

m = 3, w = 2, rank/1 = 2.

(3.23)

- 0,4744 - 0,4993 - 0,7250

Q= 0,5840 -0,7947 0,1652 ,

- 0,6587 - 0,3450 0,6687

15

Г0’

А = 0-

L0-'

Я =

4087 0,1594

,4302 0,3516

,6246 0,3384

0,8615 -0,4965

0,0 - 0,1304

Случай За. Матрица недоопределена и имеет полный ранг:

т=2, n=3, rank А =2.

AQ = [R : 0],

,4087 0,4301 0,6246‘

594 0,3515 0,3384 J ’

- 0,4744 0,5840 - 0,6587

- 0,4993 - 0,7947 - 0,3450

- 0,7250 0,1652 0,6687

- 0,8615 0,0 1

- 0,4965 - 0,1304 J

Случай 1Ь. Квадратная вырожденная матрица:

m =п = 5, rank А = 3.

R 0

Г 0,4

10,1

Q-

R =

QAK

О О

0,0986

- 0,6926

- 0,5937

- 0,0522

- 0.394Г

0,3748

0,0072

- 0,5424

0,3529

0,6639

е =

-0,1244

0,2438

- 0,3484

- 0,8633

0,2419

0,2401

- 0,6653

0,4813

- 0,2980

0,4234

_ 0,8813

0,1351

- 0,0160

- 0,1966

- 0,4076_

0,1376

0,4086

0,1594 0,4390

0,4113"

0,9665

0,6246

0,3383 0,7221

0,8746

А =

0,8285

0,0661

0,9112 0,6266

0,2327

»

0,0728

0,3485

0,8560 0,8348

0,2474

0,5500

0,9198

0,0080 0,7610

1,0506

“- 0,9660

0,0

0,0

0,0569

- 0,2520"

0,1279

- 0,6389

0,0

- 0,4688

- 0,5963

К =

- 0,0709

0,1861

- 0,8383

- 0,4806

0,1632

0,0726

- 0,4109

- 0,5354

0,7253

-0,1144

_- 0,2002

- 0,6231

0,1027

-0,1411

0,7357_

1,4446

1,6867

1,2530

R =

0,0

- 1,3389

- 0,1486

0,0

0,0

1,1831

(3.24)

(3.25)

16

Случай 2Ь. Переопределенная матрица неполного ранга:

m = 6, п = 5, rank Л = 3.

(3.26)

QAK

С =

0,0894

0,3768

- 0,1235

0,3354

0,7849

- 0,3259

-0,6279

0,0510

0,2301

- 0,6906

0,1389

- 0,2324

- 0,5382

- 0,4986

- 0,3633

0,4092

-0,1992

- 0,3500

- 0,0473

- 0,3573

- 0,4221“

0,3522

0,6813

- 0,1360

- 0,8609

0,2386

0,0417

- 0,2991

0,3539

0,1685

- 0,1088

- 0,4751

0,2956

0,1768

0,0153

0,8281_

R =

Случ

m = 4,

QAK =

'0,1376

0,4087

0,1593

0,4308

0,4163"

0,9667

0,6246

0,3384

0,8397

0,8029

0,8286

0,0661

0,9111

0,7495

0,1577

0,0728

0,3485

0,8560

0,8068

0,2644

»

0,5501

0,9198

0,0080

0,7910

1,0323

_0,6498

0,2725

0,3599

0,5350

0,3801_

~- 0,9846

0,0

0,0

—

0,0868 -

0,1520"

0,1343

- 0,6392

0,0

—

0,4230 -

0,6281

0,0177

0,1650

- 0,8460 -

0,4808

0,1598

- 0,0467

- 0,3820

- 0,5248

0,7488 -

0,1256

0,1006

- 0,6468

0,0942 -

0,1469

0,7356

1,5636

1,7748

1,4574 "

0,0

- 1,3537

- 0,1233

0,0

0,0

1,1736 _

як ЗЬ. Недоопределенная матрица неполного ранга:

п = 5, rank А = 3.

(3.27)

(2 =

А =

Л 0 1

. О О J ’

■- 0,9757

0,0

0,0

-0,2193

0,4087

0,6246

0,0661

0,2112

0,0103

- 0,9989

0,0

- 0,0458

0,1593 0,6594

0,3383 0,6591

0,9112 0,6898

0,8150 0,7983

0,1390

0,0298

- 0,7729

-0,6184

- 0,1693

- 0,0363

- 0,6345

0,7533

0,4302 0,3516'

0,9342 0,9038

0,1931 0,1498

0,3406 0,2803

2.4. Лоусон

17

0,4225

0,0249

0,3156 -

0,0047 -

0,8493"

- 0,1647

- 0,1529

- 0,9349 -

0,0530 -

0,2696

К =

- 0,6816

0,6377

- 0,0851

0,1253

0,3254

-0,4447

- 0,4483

0,1187 -

0,7222

0,2561

0,3634

- 0,6070

0,0713

0,6782

0,1858_

'0,9915

0,0

0,0 1

R =

1,5246

1,2573

0,5840

- 0,1388

0,0

1,1077 J

У пражнения

3.28. Найти спектральное разложение матрицы

II w || = 1.

Хаусхолдера Н - I -

3.29. Найти спектральное разложение маърицы отражения Гивенса из (3.10).

3.30. Показать, что G из (3.10) является матрицей Хаусхолдера.

ГЛАВА 4

ОРТОГОНАЛЬНОЕ РАЗЛОЖЕНИЕ

ПОСРЕДСТВОМ СИНГУЛЯРНОГО РАЗЛОЖЕНИЯ

В этой главе будет описано еще одно практически полезное ортогональ¬

ное разложение т X л-матрицы А. В предыдущей главе матрица А была

представлена произведением HRKT, где R — некоторая прямоугольная

матрица, ненулевые элементы которой сосредоточены в невырожденной

треугольной подматрице. Мы покажем здесь, что эту невырожденную под¬

матрицу R можно еще более упростить так, чтобы она стала невырожден¬

ной диагональной матрицей. Получаемое в результате разложение особенно

полезно при анализе влияния ошибок входной информации на решение

задачи НК.

Это разложение тесно связано со спектральным разложением симметрич¬

ных неотрицательно определенных матриц АТА и ААТ, Стандартные факты,

касающиеся спектральных разложении симметричных неотрицательно опре¬

деленных матриц, приведены в приложении А.

Теорема 4.1 (сингулярное разложение). Пусть А - m X п-матрица

ранга к. Тогда существуют ортогональная m X m-матрица U, ортогональ¬

ная п X п-матрица V и диагональная m X п-матрица S*) такие, что

UTAV = S, А - USVT. (4.2)

Матрицу S можно выбрать так, чтобы ее диагональные элементы составля¬

ли невозрастающую последовательность; все эти элементы неотрицательны

и ровно к из них строго положительны.

Диагональные элементы S называются сингулярными числами А. Будет

удобно дать доказательство теоремы 4.1 вначале для специального случая

*) То есть m X «-матрица S такая, что sy # 0 -»/=/. {Примеч. пер.)

1в

т =п » ranki4. Более общее утверждение легко следует из этого специаль¬

ного случая.

Лемма 4.3. Пусть А - п X п-матрица ранга п. Тогда существуют орто¬

гональная п X п-матрица V, ортогональная п X п-матрица V и диагонмьная

п Хп-матрица S такие, что

UTAV = S, А = USVT (4.4)

и последовательные диагональные элементы S положительны и не

возрастают.

Доказательство. Положительно определенная симметричная

матрица А ТА допускает спектральное разложение

ATA = VDVT, (4.5)

ще V — ортогональная п X п-матрица, a D - диагональная матрица, причем

диагональные элементы/) положительны и не возрастают.

Определим S как диагональную п X и-матрицу, диагональные элементы

которой суть положительные квадратные корни из соответствующих диаго¬

нальных элементов D. Таким образом,

D = STS=S2, (4.6)

S-'DS-l=I„. (4.7)

Определим п X я-матрицу

U = AVS~l. (4.8)

Из (4.5), (4.7), (4.8) и ортогональности V следует, что

UTU = S-' VTATAVS-' =S'lDS'1 =/„, (4.9)

i.e. U ортогональна.

Из (4.8) и того обстоятельства, что V ортогональна, выводим

USVT =AVS-'SVT =AVVT =А. (4.10)

Лемма 4.3 доказана.

Доказательство теоремы 4.1. Пусть

А = HRK т, (4.11)

где H,R,KT имеют свойства, указанные в теореме 3.19.

Так как k X к-матрица R\ \ из (3.21) невырождена, то согласно лем¬

ме 4.3, можно написать

Rn=USVT. (4.12)

Здесь U и V - ортогональные к X к-матрицы, a S - невырожденная диаго¬

нальная матрица, диагональные элементы которой положительны и не

возрастают.

Из (4.12) следует, что матрицу R уравнения (3.21) можно записать

в виде

R = USVT, (4.13)

2* i?

А

где U - ортогональная mXm-матрица:

М"° 1.

[о 1,„_к J

(4.14)

Л

V —ортогональная лХл-матрица:

(4.15)

и 5 - диагональная т X п-матрица:

ч5 °i

I о о J

(4.16)

Теперь, определяя U и V формулами

А

V = KV,

заключаем из (4.11) -(4.18), что

A =USVT,

U = HU,

Л

(4.17)

(4.18)

(4.19)

где U, S и V имеют свойства, указанные в формулировке теоремы 4.1.

Это завершает доказательство.

Заметим, что сингулярные числа матрицы А определены однозначно

несмотря на то, что в выборе ортогональных матриц U и V из (4.19) есть

произвол. Пусть о - сингулярное число А, имеющее кратность /. Это значит,

что для упорядоченных сингулярных чисел найдется индекс / такой, что

О = Sj, / = /,/+ 11,

o=tSj, j<i или />/+1.

В л-мерном пространстве / мерное подпространство Т, натянутое на

столбцы Vj, /=/,...,/+/ — 1, матрицы У, определено однозначно; однако

однозначности нет при выборе ортогонального базиса в Г, каковым яв¬

ляются названные столбцы V.

Более точно, положим к = min(ra, п), и пусть Q — ортогональная

к X А:-матрица вида

<2 =

Здесь Р - ортогональная / X /-матрица. Если А = USVT — сингулярное

разложение А и Sj = .. . = s, + /_j, то USVTt где

также будет сингулярным разложением А.

20

В следующем численном примере дано сингулярное разложение матри¬

цы А вида (3.23):

A-V

и=

У =

S

- 0,4347

- 0,5509

-0,7125

0,9965

0,0

- 0,8626

- 0,5058

(4.20)

0,6141

- 0,7599

0,2129

0,0

0,1128

0,5058 1

- 0,8626 J

- 0,6587

- 0,3450

0,6687 J

Упражнения

4.21. Если А - симметричная п X п-матрица и ее сингулярные числа различны, то:

a) (действительные) собственные значения А различны;

b) с помощью сингулярного разложения матрицы А можно найти ее спектральное

разложение, и наоборот.

Что можно сказать о случае, когда среди сингулярных чисел имеются кратные?

4.22. Если $, - наибольшее сингулярное число А, то II А II = s,.

4.23. Если R - невырожденная я X л-матрица и s„ - ее наименьшее сингулярное

число, то II Л"1 II =*л‘.

4.24. Пусть «, и sn - соответственно наибольшее и наименьшее сингулярные числа

т X n-матрицы А ранга п. Показать, что для любого л-вектора х

s„ II * II < II Ах || < s, || х II.

4.25. Пусть sic - ненулевые сингулярные числа А. Тогда

М II/г = ( 2 s?)1/2.

i = 1

т

4.26. Пусть А = US V - сингулярное разложение А. Показать, что столбцы U суть

Т

собственные векторы симметричной матрицы АА .

ГЛАВА 5

ТЕОРЕМЫ О ВОЗМУЩЕНИЯХ СИНГУЛЯРНЫХ ЧИСЕЛ

Сингулярные числа матрицы очень устойчивы к изменению ее элементов.

Возмущения элементов матрицы приводят к возмущениям той же или

меньшей величины в ее сингулярных числах. Цель данной главы - предста¬

вить теоремы 5.7 и 5.10, которые дают точные формулировки этой устойчи¬

вости, и теорему 5.12, указывающую оценки возмущений сингулярных чи¬

сел при удалении из матрицы столбца или строки.

Эти теоремы являются прямыми следствиями соответствующих теорем

об устойчивости собственных значений симметричной матрицы. Вначале

мы сформулируем три относящиеся сюда теоремы о собственных значениях.

Теорема 5.1. Пусть В, А, Еш - симметричные п X п-матрицы и В А =

= Е. Обозначим собственные значения этих матриц, упорядоченные по не-

г\

возрастанию, соответственно через 0,, ah е,-, / = 1л. Тогда

еп </3,--а(<€ ь / = 1,. . . , п.

Часто бывает полезно более слабое неравенство, которое требует зато

Теорема S3. Пусть А - симметричная п X п-матрица с собственными

значениями oti > . .. > а.п. Пусть к - целое число, \ <к<п. Пусть В - сим¬

метричная матрица порядка п - 1, полученная удалением из А k-й строки

и k-го столбца. Тогда собственные значения 0{ матрицы В, также зануме¬

рованные в порядке невозрастания, разделяют собственные значения А :

с*1 >01 >а2 >02 ^ ■ • ^0„_i

Обсуждение и доказательства этих трех теорем, равно как и минимакс¬

ной теоремы Куранта-Фишера, которую используют теоремы 5.1 и 5.3,

читатель может найти в книге [7]. Теорема 5.2 впервые опубликована

в [100]; ее обобщение обсуждается в [196].

Чтобы вывести из этих теорем о возмущениях собственных значений

теоремы о возмущениях сингулярных чисел, мы воспользуемся связью,

существующей между сингулярным разложением матрицы Л и спектраль¬

ным разложением симметричной матрицы

то матрица С, определенная формулой (5.4), имеет спектральное разло¬

жение

менее детальной информации относительно Е:

I 0, - а/ К max | ef | = || Е ||, / = 1,.. . , л.

/

Теорема 5.2 (Виландта - Хофмана). В условиях теоремы 5.1

п п п

Г0

с~[ат

(5.4)

т

Если А - квадратная и имеет сингулярное разложение А = US V , то лег¬

ко проверить, что С имеет спектральное разложение

где U -2 l/2U и V = 2~1/2 V.

Если m X я-матрица А (т> п) имеет сингулярное разложение

(5.5)

5 0 0

А=Р 0 -S 0 РТ,

ООО

22

где

г£<1) _£(») t/(2)-

Р~1 V V О J ’

t/<* > = 2-1 /2t/<l), V = 2~l,1V.

Ясно, что аналогичные результаты справедливы в случае m < п. Для

последующих ссылок мы сформулируем теорему 5.6, вытекающую из

вышесказанного.

Теорема 5.6. Пусть А - m X п-матрица и к = min (m, п). Пусть С -

симметричная матрица порядка m + п, определенная формулой (5.4).

Если Si, ..., sk - сингулярные числа А, то собственные значения С суть

S\»... ,Sk, - Si,.. . , - sk и нуль, повторенный I m - п | раз.

Мы можем теперь сформулировать три теоремы, относящиеся к возму¬

щениям сингулярных чисел.

Теорема 5.7. Пусть В, А, Е - тХ п-матрицы и В - А =Е. Обозначим

сингулярные числа этих матриц, упорядоченные по невозрастанию, соот¬

ветственно через 0/, а/, е,-, / =1,...,Л; k = min(w, п). Тогда

I 0/-е*|<€1 =\\Е\\, i = 1,... ,к. (5.8)

Доказательство. Введем симметричные матрицы

О Е

Ет О

Тогда В - А = Е. Связь собственных значений этих матриц с сингулярными

числами В, А и Е указана в теореме 5.6. Применяя к матрицам В,АиЕ тео¬

рему 5.1, получим неравенства 5.8.

Теорема 5.10. В условиях теоремы 5.7 справедливо неравенство

к к m п

1 (0,-а,)2< 2 е,2= 2 2 el = \\E\\2F. (5.11)

/=1 / = 1 i = i / = 1 7

Доказательство. Вводя те же матрицы (5.9) и используя теоре¬

мы 5.6 и 5.2, получим

2 2 II £4l£ = 2imi?r,

что эквивалентно неравенству (5.11).

Теорема 5.12. Пусть А - m X п-матрица. Пусть к - целое число,

1 < к < п. Пусть В - m X (л - \)-матрица, полученная из А удалением

к-го столбца. Если занумеровать сингулярные числа /3,- матрицы В в поряд¬

ке невозрастания, то они будут разделять сингулярные числа а,- матрицы А

следующим образом:

1) m >п\

«1 >Pi ><*2 >02 > . . . >0„-1 ><*„ >0; (5.13)

2) m < п :

^1 > 01 > > 02 > • • • > > 0т >0* (5*14)

23

Доказательство. Неравенства (5.13) и (5.14) получаются пря¬

мым применением теоремы 5.3 к симметричным матрицам А = А7А и £ =

= ВтВ. В случае 1) собственными значениями А и В будут соответственно

числа a*, i = 1,... f л, и 0*, / = 1,. .., п - 1. В случае 2) собственные зна-

Л л w

чения А суть а/, / = 1, . .. , т, и нуль, повторенный п - т раз, а собствен-

Л Л

ные значения 5-0/, / = 1, ..., ту и нуль, повторенный п — 1 — т раз.

Упражнения

5.15. Задача [51 ]. Даны т X п-матрица А ранга к и неотрицательное целое число

г, г < к. Найти т X я-матрицу В ранга г, минимизирующую II В - А И р.

Т

Решение. Пусть А = USV - сингулярное разложение А с упорядоченными син¬

гулярными числами s j > ... > Sfr > 0. Пусть S получена из S заменой чисел sr +1,...

~ ~ гг

. . ., нулями. Показать, что матрица В р US V решает поставленную задачу, и вы¬

разить II В - А || р через сингулярные числа А.

Замечание. Это доказательство прямо вытекает из теоремы 5.10. Доказатель¬

ство, предложенное Экартом и Янгом, по существу, содержите себе и доказательство

теоремы 5.10.

5.16. Решить задачу 5.15, заменив ll-llp на II II.

5.17. Определим к(А) как отношение наибольшего сингулярного числа матрицы А

к ее наименьшему ненулевому сингулярному числу. (Это "число обусловленности’М

будет использоваться в последующих главах.) Показать, что если ранг m X л-матрицы

А равен п, a m X г-матрица Я получена из/4 удалением/i - г столбцов, то к(В) < к(А).

ГЛАВА 6

ОЦЕНКИ ДЛЯ ЧИСЛА

ОБУСЛОВЛЕННОСТИ ТРЕУГОЛЬНОЙ МАТРИЦЫ

При практическом анализе задачи наименьших квадратов в гл.25 возник¬

нет необходимость в оценке наибольшего и наименьшего ненулевого сингу¬

лярных чисел матрицы А: отношение этих двух величин (число обуслов¬

ленности А) интерпретируется как коэффициент увеличения ошибки.

Эта интерпретация числа обусловленности будет представлена в гл. 9.

Наиболее прямой подход состоит в том, чтобы вычислить сингулярные

числа А (см. гл. 4, 18). Однако часто бывает желательно получить оценку

для числа обусловленности, не вычисляя сингулярных чисел. В данной главе

будут изложены некоторые теоремы и примеры, связанные с этой задачей.

Большинство алгоритмов, описываемых в этой книге, порождают в ка¬

честве промежуточного результата невырожденную треугольную матрицу

(назовем ее R), имеющую те же ненулевые сингулярные числа, что и исход*

ная матрица Л. В общем случае невырожденная треугольная матрица явля¬

ется лучшим отправным пунктом при оценке обусловленности, чем запол¬

ненная матрица. Поэтому мы ограничимся оценками сингулярных чисел

только для невырожденной треугольной матрицы R.

Обозначим упорядоченные сингулярные числа невырожденной треуголь¬

ной п X и-матрицы R через sx > , .. > sn > 0. Как отмечено в упражне¬

нии 4.22, si = || R ||. Отсюда получаем легко вычислимую нижнюю оценку

24

ДЛЯ sj:

Si >max |r«|. (6.1)

U

Далее, так как R треугольная, то числа, обратные к диагональным элемен¬

там Л,суть элементы R~l. Поэтому

||/Г1 || > шах IV |. (6.2)

/

Согласно упражнению 4.23, s~l = || Я-1 ||, откуда

s„ < min | гн |. (6.3)

/

Итак, нижнюю границу р для числа обусловленности к = sjsn дает не¬

равенство

к >р =

шах | ги |

*./

min | г и |

i

(6.4)

Эта нижняя граница, хотя и не лишена практической пользы, не может,

вообще говоря, рассматриваться как надежная оценка для к. В самом деле,

к может быть значительно больше, чем р.

Это показывает пример (см. [108]) верхней треугольной п X п-матри¬

цы R, определяемой формулами

0,/</,

(6.5)

1, / = 1\

, -

1,/>£

Например,

для п =

4

'1

- 1

- 1

- 1

п _

0

1

- 1

- 1

К -

0

0

1

- 1

0

0

0

1

(6.6)

Используя (6.4), получим р = 1 в качестве нижней границы для к. Эта оцен¬

ка не содержит никакой информации. Для данной матрицы более реалисти¬

ческую верхнюю границу для sn можно вывести, рассматривая действие R

на вектор у с компонентами

= /= 1,... ,п - 1, Уп=У„_1. (6.7)

Легко проверить, что Ry = z, где

Г/ = 0, — 1, z„ = 22~n. (6.8)

Теперь, используя неравенства

^ НЯ1 ^ 1

= ня-

,2-л

(6.9)

находим

к =sl/sn>2n~2.

(6.10)

25

Таблица 6.1

Последний диагональный элемент R и последнее сингулярное число R

п

гпп X Ю8

sn X 10е

sn!rnn

20

330

286

0,867

21

165

143

0,867

22

82,5

71,6

0,868

23

40,5

35,8

0,884

24

20,5

17,9

0,873

25

8,96

8,95

0,999

26

4,59

4,52

0,985

Неравенство (6.9) можно интерпретировать и так: оно показывает, что R

близка к вырожденной матрице. Близость понимается в том смысле,.что

существует матрица Е такая, что \\Е\\ <22_п и матрица R-Е вырожде¬

на. Легко проверить, что нужная матрица задается формулой Е = zyT/yTy.

для „ = 4 у = (1, 1/2, 1/4, 1/4) т, г = (0, 0, 0, 1/4) т, *.4 < 1/4, к > 4.

Кроме того, при вычитании матрицы

0

0

0

0

0

0

0

0

0

0

0

0

2

1

1

1

_11

11

22

22.

из матрицы R (см. (6.6)) получим вырожденную матрицу.

Этот пример показывает, что иногда опасно считать матрицу хорошо

обусловленной даже в том случае, когда р в (6.4) мало, а матрица выгля¬

дит вполне ’’невинно”.

Напомним, что нас интересуют главным образом треугольные матрицы,

возникающие в алгоритмах решения линейных систем. Матрица, определяе¬

мая формулами (6.5), обсуждалась в литературе в связи с тем, что она ин¬

вариантна относительно гауссова исключения как с частичным, так и с пол¬

ным выбором главного элемента. Однако она не будет инвариантна отно¬

сительно исключения посредством преобразований Хаусхолдера, сопро¬

вождаемого перестановками столбцов (так обстоит дело, например, в

алгоритме HFTI, который будет описан в гл. 14).

В этой связи и в качестве численного эксперимента мы применим алго¬

ритм HFTI к матрице R из (6.5) . Пусть R обозначает треугольную матрицу,

полученную в результате этой операции. Мы вычислили также сингулярные

числа R. Вычисления проводились на машине UN IV А С 1108 в режиме сме¬

шанной точности (см. гл. 17) , характеризуемом использованием как ариф¬

метики с обычной точностью (т) = 2"21 % 0,745 X 10-8), так и арифметики

с удвоенной точностью (со = 2“58 ^0,347 X 10“17). В табл. 6.1 представ¬

лены вычисленные значения последнего диагонального элемента гпп и

наименьшего сингулярного числа s„, а также отношения sn/rnn для значе¬

26

ний п от 20 до 26. Заметим, что во всех случаях гпп дает хорошую оценку

величины s п.

Тем не менее существуют л X л-матрицы с нормированными столбцами,

которые могут быть порождены алгоритмом HFTI и у которых наимень¬

шее сингулярное число приблизительно в 2п~1 раз меньше, чем наимень¬

ший диагональный элемент.

Пример такой матрицы, который мы сейчас приведем, принадлежит

Кахану [108] . Определим лХл-матрицу R формулами

( 0, i>j,

гцА /=/,

l-rs'-1, /</.

Здесь sue- положительные числа, причем s2 + с2

Я =

1

- с

- с

- с

0

S

- CS

- CS

0

0

S2

- cs2

0

0

0

s3

1. Например, для п = 4

(6.11)

Для любого л матрица R верхняя треугольная, ее столбцы имеют единичную

евклидову длину, и выполняются неравенства

> Z г.?., к = 1,.. . , п - 1, / = А: + 1,. . . , л.

i=k

(6.12)

Как устанавливается в гл. 14, эти неравенства означают, что матрица R мо¬

жет быть получена в результате применения алгоритма HFTI к некоторой

матрицей.

Пусть T = R~l. Элементы Т выражаются формулами

/</,

Uj-

0,

1

е/-1

с(1 + с* У 1 1

s'-1

Например, в случае л = 4

с

1 —

R~ =Г =

/ =/,

/ = /+1,

/ -i> 2.

с(1 + (?)

с(1 +С)2

с( 1 + с)

27

Пусть г„ обозначает последний столбецR~l. Тогда

, / с2[(1 +с)2"-2 - 1] \ ,

"’■‘Г' (, +<•)*-■ У--

Когда s ->+0, а с = (1 - s2)1/2 -► 1 - 0, произведение || тп \\2г2пп> возрас¬

тая, стремится к (4',_l + 2)/3. Поэтому найдется значение s, зависящее

от и, для которого

II

Так как, согласно упражнению 4.24,

г II Яг,, II 1

S" " II Т„ II II т„ II ’

то

sn ^ 31 /22* “” | rnn | *= 1.73 • 21 ~” | г„„ |.

Следующая теорема показывает, что в рассмотренном примере реализует¬

ся почти минимальное значение, которого может достигать отношение

sn / I гп П I ♦

Теорема 6.13 [9J. Пусть А - пгХ п-матрица ранга п. Предположим,

что все столбцы А имеют единичную евклидову длину. Пусть R - верхняя

треугольная матрица, полученная процессом хаусхолдеровой триангуляри-

зации А с перестановками столбцов (так обстоит дело, например, в алгорит¬

ме HFTI из (14.9)). Тогда sn - наименьшее сингулярное число А и -

последний диагональный элемент R связаны неравенствами

(6.14)

sn >3(4" + 6и - 1Г,'2|г„п1>21-"|г„„ |. (6.15)

Доказательство. Из способа, которым строится R, видно, что

ее столбцы имеют единичную евклидову длину, а сингулярные числа те же,

что и у А. Кроме того, перестановки столбцов обеспечивают выполнение

неравенств

/

r\k > Е /•?., Л=1,...,л-1, /=Л + 1,.. . ,и. (6.16)

i-k

Из (6.16) следует, что

\гкк\>\гц\, i>K />*, * = 1,...,и-1. (6.17)

Так как

*„=11 Л-'Г1, (6.18)

то неравенства (6.14) и (6.15) эквивалентны неравенствам

II Л-1 || > |г“Д |, (6.19)

II R-1 II < 3-11 (4я + 6п - 1У721 r;ln |. (6.20)

Неравенство (6.19) - следствие того факта, что г~„ является элементом

матрицы/?’1.

28

Чтобы доказать (6.20), мы выведем верхние границы для величин всех

элементов Л"1, а затем вычислим норму Фробениуса мажорирующей

матрицы М.

Положим Т = R~l. Будет удобно сгруппировать элементы Т по диагона¬

лям, параллельным главной. Введем мажорирующие параметры для диаго¬

налей следующим образом:

gk =шах{ | titi+kI, i = 1,..., п — к) , к =0,1,..., п - 1. (6.21)

Тогда

*о * max | ta | e max | rjtx I = | r~ln |. (6.22)

Элементы к-и наддиагонали Т можно выразить через элементы главной

диагонали Г, элементы предшествующих наддиагоналей Т и элементы R:

U, 1+к —

(6.23)

1<1<л-1, 1 <k<n-i.

Так как \rt /+/| < 1/7/1, то из (6.21) и (6.23) получаем

к к к — 1

gk = шах Uf,/+*| Стах 2 |г/+//+*|< 2 gk_. = 2 g,.

I I 1 = 1 i=i K i=o '

Легко проверить по индукции, что

= 2fc_ 11 |, к = 1,...,п.

Определим верхнюю треугольную п X л-матрицу М формулами

0,

1,

2/-(-1

и положим

м=\г;'п\м.

Например, для п = 4

1

1

2

4

0

1

1

2

0

0

1

1

0

0

0

1

(6.24)

(6.25)

(6.26)

(6.27)

М =

Из (6.21) и (6.25)—(6.27) следует, что элементы Л-1 (= Т) мажори¬

руются соответствующими элементами М. Поэтому

= II R l II < II Л'1 ||F< ||A/||f = | r~' | \\M ||F. (6.28)

Чтобы вычислить норму Фробениуса матрицы М„ заметим, что для j > 2

29

сумма квадратов элементов столбца / равна

1-2 4/-1 +2

к? = 1 + 2 4'= . (6.29)

' / = о 3

Это выражение верно и при / = 1, если считать, что сумма в средней части

равна нулю.

Теперь

о п 4W +6/1 — 1

WR-1 \\2Р - II Т\\% <г?н \\ М \\2Р = г~гп 2 w} =r-„l . (6.30)

j = 1 У

Неравенства (6.28) и (6.30) вместе устанавливают неравенство (6.20).

Теорема 6.13 доказана.

Теорема 6.31 [9]. Пусть А и Яте же, что и в теореме 6.13. Сингуляр¬

ные числа sx > ... > sn матрицы А связаны с диагональными элементами

Гц матрицы R неравенствами

21 -1'■ | ги |< 3 (411 + 6 / - 1)~1 /21 ги | < s, < (л - / + 1У >'■21 г„ |, / = 1,..., п.

(6.32)

Доказательство. Пусть Rj — ведущая главная подматрица по¬

рядка j матрицы R. Обозначим через /-е сингулярное число Rj. Из

теоремы 5.12 вытекают неравенства

_ (w) ^ (Л ~ ^ (0

Sj =Sf >Sf > .. . >sf . (O.JJ)

Применяя к Rj теорему 6.13, получим

sj° > 3(4'' + 6/ - 1)-1/2| r„l. (6.34)

Это неравенство вместе с (6.33) доказывает нижнюю оценку для S/ в (6.32).

Определим Wj как главную подматрицу порядка п + 1 -/, стоящую в R

на пересечении строк и столбцов с номерами п. Заметим, что первым

диагональным элементом является ri{. Используя (6.16) и упражне¬

ние 6.37, получаем

|| W,\\ <(« + 1 -01/21»д1- (6-35)

Обозначим через oj(^ <-е сингулярное число Wj. Согласно теореме 5.12,

можно написать

Sj = ы/1} < «,(0. (6.36)

Так как = II ||, то (6.35) и (6.36) вместе устанавливают верхнюю

оценку для Sj в (6.32). Теорема 6.31 доказана.

У пражнение

6.37. Пусть А - m X я- матрица со столбцами ау. Тогда

шах || <zy ||.

)

30

ГЛАВА 7

ПСЕВДООБРАТНАЯ МАТРИЦА

Если А - невырожденная л X л-матрица, то решение системы Ах = b

можно записать в виде х - А~х Ь, где А~х — (единственная) обратная мат¬

рица ддя А. Обратная матрица - это очень полезное математическое по¬

нятие даже при том, что эффективные и надежные современные методы

[7,11] для решения системы Ах = b не требуют явного вычисления А .

В случае задачи НК возникает вопрос: существует ли л X л?-матрица Z,

однозначно определяемая матрицей А и такая, что (единственное) реше¬

ние минимальной длины задачи НК выражается формулой jc = Zb. Такая

матрица Z действительно существует; она называется псевдообратной для

матрицы А. Как и обычная обратная, псевдообратная матрица — полез¬

ное математическое понятие, но при решении задачи НК ее, как правило,

не вычисляют в явном виде.

Следующие две теоремы приводят к конструктивному определению

псевдообратной для m X л-матрицы А.

Теорема 7.1. Пусть А - тХ п-матрица ранга к с ортогональным раз¬

ложением A =HRKT, удовлетворяющим предположениям теоремы 2.3.

Тогда единственное решение минимальной длины задачи НК выражается

формулой

01 х

НТЪ. (7.2)

1Г

о

Доказательство. Формула (7.2) есть просто иной способ записи

равенств (2.5)-(2.7) и (2.11).

Теорема 7.3. Пусть A =HRK т$ как и в теореме 7.1,

Н1

Матрица Z однозначно определена матрицей А и не зависит от конкрет¬

ного ортогонального разложения А.

Доказательство. Для каждого /, 1 </ < ту /-й столбец zy матри¬

цы Z можно записать в виде Zj=Zej, где ^ -/-й столбец единичной мат¬

рицы^. Согласно теореме 7.1, Zj — единственное решение минимальной

длины для задачи наименьших квадратов Ах = еу. Теорема 7.3 доказана.

Исходя из теорем 7,1 и 7.3, дадим следующее определение.

Определение 7.4. Для произвольной т X п-матрицы А псевдооб¬

ратная матрица, обозначаемая через А* , - это п X т-матрица, j-й столбец

Zf которой является единственным решением минимальной длины для за¬

дачи наименьших квадратов Axj ^ где - j-й столбец единичной мат-

рицы Im.

Это определение с учетом теорем 7.1 и 7.3 непосредственно приводит

к записи решения минимальной длины задачи НК в виде

х =А+Ь. (7.5)

31

Следующие два случая заслуживают специального упоминания. Для

квадратной невырожденной матрицы В псевдообратная матрица совпадает

с обычной обратной:

где RII— невырожденная к X ^-матрица, псевдообратная — это л X т-мат-

рица вида

Псевдообратную для т X л-матрицы А можно охарактеризовать и дру¬

гими способами. Каждая из двух следующих теорем дает иную характе¬

ризацию псевдообратной матрицы.

Теорема 7.8. Если А = HRK Т - произвольное ортогональное разло¬

жение А, удовлетворяющее условиям теоремы 2.3, то А + = KR +Н т, где R +

задана формулой (7.7).

Теорема 7.9 (условия Пенроуза [138]). Псевдообратная А+ для

m X n-матрицы А - это единственная n X m-матрица X, которая удовлетво¬

ряет следующей системе условий :

а) АХ А =Л; Ъ)ХАХ=Х-, с)(АХ)т=АХ; d )(ХА)Т=ХА.

Доказательства этих двух теорем предоставляются читателю в качестве

упражнений.

Явное представление , указанное в теореме 7.8, особенно полезно

для вычислений. Если, например, для А имеется ортогональное разложе¬

ние (3.20) и /?ц в (3.21) - невырожденная треугольная матрица, то

Если же имеем сингулярное разложение (4.2), описываемое в теоре¬

ме 4.1, то

Как отмечено в начале этой главы, обычно нет нужды в явном построе¬

нии псевдообратной для матрицы А. Например, если целью вычислений

является решение задачи НК, то более экономично как по времени, так

и по памяти разбить процесс решения на следующие три шага (которые,

по существу, повторяют доказательство теоремы 2.3) :

В+ = В1.

Для m X л-матрицы

(7.6)

(7.10)

А* = VS*UT.

(7.11)

(7.12)

(7.13)

3 )х = К

(7.14)

32

Упражнения

7.15. Проверить формулы (7.6) и (7.7).

7.16. Доказать теорему 7.8.

7.17. [138]. Доказать теорему 7.9.

7.18. Доказать, что (А + )т = (АТУ и (/Г)* “ А-

7.19. Если QmXn имеет ортонормальные столбцы или ортонормальные строки, то

Q* я QT, Если QmXn имеет Р3111, п и Удовлетворяет условию Q* = QT, то столбцы Q

ортонормалькы.

7.20 [138]. Если Uи V имеют ортонормальные столбцы, то (UAV )* = VA + U

7.21. а) Пусть А = USVT - сингулярное разложение А, Выписать выражения для

сингулярных разложений четырех матриц Р, - A*AtP2 =/ -А*АуРг = АА* , Р4-

* / - А А* через матрицы t/, S, V.

■) Вывести из (а), что матрицы Р{ являются симметричными идемпотенгами и,

следовательно, проекционными матрицами.

с) Пусть Т{ - подпространство, ассоциированное с проекционной матрицей Я/,

Т.е. 7) *{х: Р{Х- *}. Указать связь каждого подпространства 7/ с пространством

СХрок шш пространством столбцов А.

1.22. Доказать, что общее решение задачи Ах =* b выражается формулой х = А * Ь +

♦ (Г - А* А) у у где.у - произвольный вектор.

7.23 [84]. Для невырожденных матриц имеется тождество СЛВ)~1 = В~хА 1.

Аналогичное соотношение {АВ)* = В* А* выполняется не для всех матриц Атхк и

BkXrt

а) Указать две матрицы А и В такие, что т = п = 1, А' = 2 и (А В)* Ф В* А+ .

в) Доказать, что матрицы Л и В удовлетворяют соотношению {А В)* = В* А+ тог¬

да и только тогда, когда образ В является инвариантным подпространством для АТЛ,

Т

а образ А (т.е. пространство строк А) является инвариантным подпространством

дш ВВ rp j’

7.24. Если rank Amxn = п* то А* = (А ^ * А

Если xankAmx„ = m, то А* = АТ(АА ) ‘. т

7.25 [81,138]. Для произвольной матрицы А уравнения ХАА -А и A AY-A

совместны. Если матрицы X и Y суть решения указанных уравнений, то ХА и А У -

проекционные матрицы (симметричные идемпотенты) и А+ = ХА У. Отметьте упро¬

щение формулировки в случае симметричной матрицы А.

7.26 [81J. Псевдообратная для прямоугольной матоииы А может быть определена

через псевдообратные для симметричных матриц АТА или ААТ (следует выбирать

более удобную) формулами А+=(АТА)*АТ или А * - АТ{ААТУСоответственно.

т т

7.27 [138]. Если А нормальная (т.е. удовлетворяет условию А А=АА ), то

А*А -АА* и 04V = (/Г )я.

7.28 [138]. Если A = ZAft причем А .А? =0 и А. А. =0 для i */, то А* + .

ГЛАВА 8

ОЦЕНКИ ВОЗМУЩЕНИЙ ДЛЯ ПСЕВДООБРАТНЫХ МАТРИЦ

Наша цель здесь и в гл. 9 — изучение связи между возмущениями вход

ных данных задачи НК и возмущениями ее решений. В этой главе будут

получены теоремы о возмущениях псевдообратных матриц, которые исполь¬

зуются в гл. 9 для исследования возмущений задачи НК.

На практике к рассмотрению таких возмущений может побуждать о грани

ченная точность, с которой наблюдаемое явление описывается количествен¬

ной информацией. Влияние погрешностей округлений, производимых в ходе

З.Ч. Лоусон

33

численной процедуры, тоже можно проанализировать так, как если бы оно

имело причиной возмущение входных данных. Подобный анализ для ал-

го ритмов, основанных на преобразованиях Хаусхолдера, будет дан в

гл. 15—17.

Результаты, относящиеся к возмущениям псевдообратных матриц

или решений задачи НК, были получены рядом авторов. Для наших целей

наиболее подходящей с точки зрения как общности, так и удобной формы

представления конечных результатов является трактовка, предложенная

в [188]. Более ранний анализ проблемы возмущений или ее специальных

случаев дан в [23, 24,80,90,139,171].

Пусть А и Е — т X и-матрицы. Определим возмущенную матрицу

А=А+Е (8.1)

и матрицу-разность

G=A' - А\ (8.2)

Мы хотим определить зависимость G от Е и, в частности, получить оценки

для П G Н через И А И и IIЕ II.

Удобно ввести четыре проекционные матрицы:

P = jCA=AtAt\ Q = AAt = AT+AT, (8.3)

Р = А*А = АТАТ+, Q = АА* • АТ*АТ. (8.4)

У этих матриц есть ряд полезных свойств, выводимых непосредственно

из условий Пенроуза (теорема 7.9). См. также упражнение 7.21 и сводку

стандартных свойств проекционных матриц, содержащуюся в приложе¬

нии А.

Матрицы, определяемые формулами (8.1) — (8.4), будут использоваться

на протяжении всей главы без ссылок на эти формулы.

Теорема 8.5. Матрица G, определенная формулами (8.1) и (8.2),

может быть представлена в виде

G = Gt +(?2 +^з> (8.6)

где

См =-А+ЕА\ (8.7)

С2 = A*(I - Q) = А*АТ+ЕГ (/-0, (8.8)

С3 = -(/ - Р)уС = (/ - Р)ЕТАТ*А*. (8.9)

Для этих матриц справедливы оценки

ВС, 11< #£• I 1Ы+ II ЧА* II, (8.10)

II С2 К Ilf И »Л+ II1 , (8.11)

II С3 II < И£ II М+1*. (8.12)

Доказательство. Представим С как сумму следующих восьми

матриц:

С=[£ +(/-?)] (A+-A+)IQ*(I-Q)\ =

= PA* Q +РА* (/.- Q)-PA*Q-PA*{I-Q) +

+ (/-P)A+Q + (/-P)A* (/- Q)-(I -P)a*Q + (I- P)A*(I- Q). (8.13)

34

Используя свойства

РХ'-А*, (/ -Р)Л* = О,

A*Q-A\ А*(1 - б) = О,

приводим (8.13) к виду

G «(A*Q-РА*) *А*Ц - С) - (/ - *

=C| +Cj + G3.

Чтобы выявить линейную зависимость G от /Г, напишем:

G, ~Л*АА*-Л+АА* = -А+ЕА*,

Gj-A:+Q(I-Q) = A+At+At(I-Q) =

= Л+ЛГ + (Ат - Ат) (/- Q) = А* Ат* Ет (/ - Q), (8.14)

Р)РА + = - (/ - Р)АТАТ*А * =

« _ (/ _ ?)(Ат - Ат) Ат+А * = (/ - Р) Ет Ат*А *.

Оценки (8.10)-(8.12) вытекают из неравенств III-Q IK 1 и II / —Р II < 1.

Теорема 8.5 доказана.

Заметим, что для действительных чисел а на (а также для квадратных

невырожденных матриц) имеется алгебраическое тождество

о~1 -я-1 -a'1 {a - а)а _1.

Казалось бы, оно означает, что для IIG II следовало ожидать оценки вида

(8.10) . Однако в (8.6) появились добавочные члены G2 и G3. Их присутст¬

вие связано с тем, что матрица либо неквадратная, либо квадратная, но вы¬

рожденная. Именно: G2 может быть ненулевой матрицей, только^если

rank Л < /и, aG3 может быть ненулевой матрицей, только если rank Л < п.

Если же rank А =т, то Q = /ш, а при гапкЛ = п будет Р = 1п.

Теперь мы хотим заменить \\А* II в правых частях неравенств (8.10) и

(8.11) ее оценкой через II А* II и IIЕ II. Получить такую оценку можно при

предположениях (8.16) и (8.17) следующей теоремы.

Теорема 8.15. Предположим, что

rank (Л +£)<гапкЛ = к> 1, (8.16)

1АЧ\\Е\\<1. (8.17)

Пусть Sk - наименьшее ненулевое сингулярное число матрицы А, а е =

* IЕ II. Тогда

гапк(Л +£) = к, (8.18)

ИЛ+И 1

НЛ*ЕУ<8|9)

Доказательство. Неравенство (8.17) можно переписать в виде

e/s* < 1 или, что эквивалентно, sk — е > 0. Пусть — к-е сингулярное чис¬

ло матрицы А = А + Е. Согласно теореме (5.7),

%(>Sk-e, (8.20)

поэтому rank (А +Е) > к, и в силу (8.16) верно (8.18) .Неравенство (8.20)

3* 35

можно записать в виде

1 1

*к Sk ~ €

что эквивалентно неравенству (8.19). Теорема 8.15 доказана.

Условия (8.16) и (8.17) необходимы. Легко проверить, что ИЛ* А может

быть неограниченной, если любое из них нарушено. Если же требовать

выполнения (8.16) и (8.17), то, помимо оценки (8.19), мы можем, исполь¬

зуя условие (8.18), показать, что в оценке (8.11) для HG2 Н произведение

\\Е\\ IIAf II2 можно заменить на II £11 II Л* И \\А* II. Это утверждение осно¬

вывается на теоремах 8.21 и 8.22.

Теорема 8.21. Если гапкЛ = гапкЛ, то

ii0(/-e)ii= \\q(i~q) I.

Доказательство. Это доказательство принадлежит Крогу [112].

Запишем сингулярные разложения матриц А и A: A^=USVthA = USVt.

Из (8.3), (8.4) и предположения о том, что А и А имеют одинаковый

ранг (скажем, к), следует

U

Определим ортогональную m. X ш-матрицу W с подматрицами Hfy соотно¬

шением

i

J?4

О

>к 0

Q-u

UT, Q= и

° 0

О

О

Wn Wv

W2l W’

22

> *

} m-k

Тогда

к

1* О

► 1

5 ^

'о

0

(2)« =

и

0 о.

ити

0

- к

UT =

\1к

о'

W

0

0

1-

0

wl2

= II wn II

0

0_

_ 0

Лл-к_

II

о

0

II

Точно так же можно проверить, что И Q(l — Q) Н = К W2\ II. Остается показать,

что II WX2 II = II W2i I. Пусть х — произвольный m — к-вектор. Положим

Используя ортогональность W, имеем П xt2 = II.у II2 = II Wy\\2 = И Wl2xl2 +

+ И W22xII2, откуда II W\2xW2 = Н jcII2 - II W22xP. Следовательно,

II Wl2 II2 = max II W^jcII2 = 1 — min II W22x\\2 = 1 - Sm

II x II = 1 H лс Я = 1

где sm_k - наименьшее сингулярное число W22.

36

Аналогично из ЛхВ2 = Ид1 II1 = II WTy IP = II Wj\хII2 + II W^2хИ2 получаем

IVj,I* = 1- min llR'k*»2 = 1 -s2m_k.

I х В = 1

Итак, I Wi21 = II W21II, что и требовалось доказать.

Теорема 8.22. Если rank Л = гапкЛ, то матрица G2, определенная

в (8.8), удовлетворяет оценке

IG2 К I £* 1 II Л*И IIЛ+II. (8.23)

До к а зател ьство, Так как гапкЛ = гапкЛ, то теорема 8.21 позво¬

ляет написать

lGal< 1ХЧ НС(/-<2)Н= И^Н 11<2(/-0И.

Поскольку

Q(f-Q) = AT*AT(I-Q) =

= АТ*[АТ - Ат) (/ - Q) = -AT*ET(I - Q),

то 1С21 удовлетворяет неравенству (8.23), что и требовалось доказать.

Теперь мы в состоянии доказать нижеследующую теорему, которую

можно рассматривать как наиболее полезный частный случай теоремы 8.5.

При более ограничительных предположениях будут получены оценки,

не включающие IIА * II.

Теорема 8.24. Пусть Gh / = 1, 2, 3, - матрицы, определенные соот¬

ношениями (8.7)-(8.9). Предположим дополнительно, что II £41 \\А* II < 1

и ranki4 <гапк>4. Тогдг гапкЛ = rank А и

\\Е\\ ИЛ + Н2

1(м И< , (8.25)

1 - Ш И/Г11

II £-11 IU + II2

IС2 И < , (8.26)

1 - Ш И/Г11

1G3K l£l IU + II2, (8.27)

с lib'll IU+II2

lGl< , (8.28)

1 — lib'll IU + II

где

1 + 5172

1,618, если rank A < min(m, ri), (8.29)

2

c = 2172 ^ 1,414, если гапкЛ = min(m, л) < max(m, л), (8.30)

с = 1, если rank>4 -m-n. (8.31)

Доказательство. To, что гапкЛ = гапкЛ, установлено в теоре¬

ме 8.15. Используя оценку для II А* II из этой теоремы, выводим неравенст¬

ва (8.25), (8.26) и (8.27) из неравенств (8.10), (8.23) и (8.12) соответ¬

ственно.

Отсюда сразу получается оценка (8.28) с с = 3. Для практических целей

этого результата вполне достаточно. Оценка для случая (8.31) также оче

37

видна, поскольку здесь IIG2 II = IIG3II = 0. Конечно, это неравенство для

квадратных невырожденных матриц хорошо известно и может быть дока¬

зано непосредственно (см,, например, [7]).

Для случаев (8.29) и (8.30) значение с определяется следующим обра¬

зом. Пусть х - нормированный m-вектор. Положим

*i = Qx, х2 = (/- Q) х.

Тогда х = хх + jc2, 1 = llxll2 = ll*i II2 + II х2 II2 и найдется число у такое,

что cosкр = IIл 1II и sinкр = 11*2 II. Пусть а> 11£Ч1 \\А* И2/(1 — II£41 \\А* II).

Согласно неравенствам (8.25) —(8.27), а> IIG/II, /=1, 2, 3. Учитывая

правые сомножители Л* и/— Q в формулах (8.7) —(8.9), имеем

Gx = Glxl +G2x2 + G3x, =У 1 +У2 Уз•

Левые сомножители в (8.7)-(8.9) - это соответственно Л*, Л* и I-P,

откуда следует, что у3 ортогонален к у у и у2. Поэтому

Следовательно, llGjtll<a(l + 5^2)/2 ^ 1,618а.

Тогда

II GII = max{II GxII: II* II = 1} < а(1 + 5 1/2)/2,

что доказывает (8.29).

В случае (8.30) либо гапкЛ = л<т, и тогда P=In, a G3 = 0, либо

тапкА - т< п, и тогда Q =/« и G2 = 0. Таким образом, либо у2, либо у г

в (8.32) обращаются в нуль, и IlGxIl2 <2а2. Это устанавливает оценку

(8.30) и завершает доказательство теоремы 8.24.

Формулы (8.1)-(8.9) и теоремы этой главы можно использовать для

доказательства того, что при соответствующих предположениях о ранге А

элементы матрицы At являются дифференцируемыми функциями эле¬

ментов А.

Примеры некоторых конкретных теорем и формул дифференцирования

приведены в упражнениях 8.33 и 9.22—9.24. Заметим, что формулы из этих

упражнений переносятся на случай, когда t — /с-мерная переменная с ком¬

понентами ..., tfc, Нужно просто заменить d\dt в этих формулах на

Дифференцирование псевдообратной матрицы было использовано в [54,

141] для алгоритмов условной минимизации. В [74, 112] дифференциро¬

вание псевдообратной матрицы применено к таким нелинейным задачам

теории наименьших квадратов, в которые часть параметров входит линейно.

II Gx II2 = IIуг +у2 II2 + И^з II2 <а2[( llx1 II + 11дг2 И)2 + И*1112] =

3 + 2sin2^ + cos2i^

= а2 <

2

а2 (3 + 51/2 )

2

Э/Эг,-, /= 1,..., к.

38

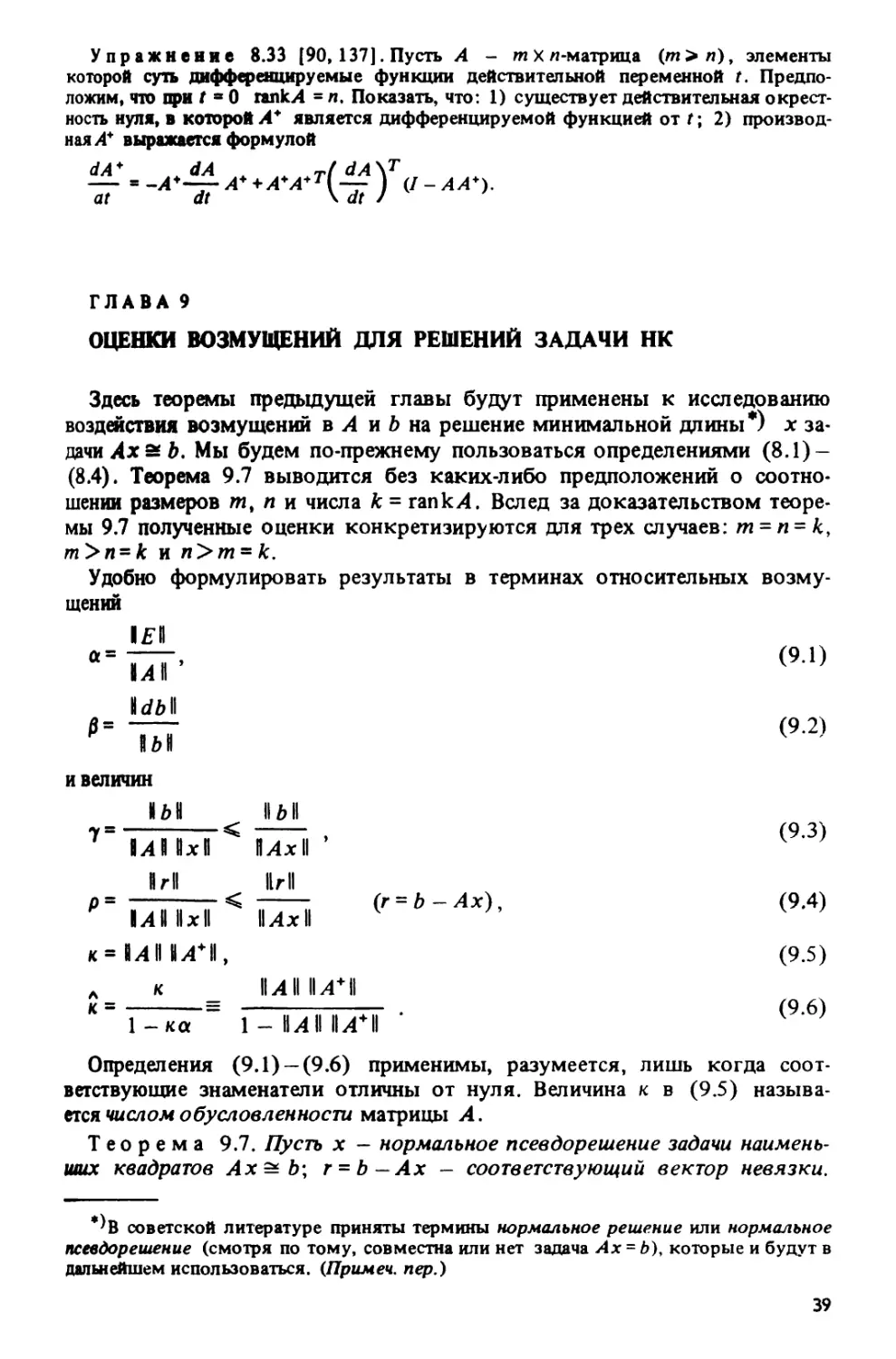

Упражнение 8.33 [90,137]. Пусть А - т х п-матрица (т> п), элементы

которой суть дифференцируемые функции действительной переменной t. Предпо¬

ложим, что при f * 0 гапкЛ = я. Показать, что: 1) существует действительная окрест¬

ность нуля, в которой А* является дифференцируемой функцией от Г; 2) производ¬

ная А* выражается формулой

— ■ -А*~ А* + А*А*Т(-^ Y (I - АА*).

at dt \dtJ

ГЛАВА 9

ОЦЕНКИ ВОЗМУЩЕНИЙ ДЛЯ РЕШЕНИЙ ЗАДАЧИ НК

Здесь теоремы предыдущей главы будут применены к исследованию

воздействия возмущений в А и b на решение минимальной длины*) х за¬

дачи Ах 2 Ъ. Мы будем по-прежнему пользоваться определениями (8.1)-

(8.4). Теорема 9.7 выводится без каких-либо предположений о соотно¬

шении размеров mt п и числа к = гапкЛ. Вслед за доказательством теоре¬

мы 9.7 полученные оценки конкретизируются для трех случаев: т = п = к,

т>п = к и п>т = к.

Удобно формулировать результаты в терминах относительных возму¬

щений

Ш

а=777> <9Л)

ып

Idbl

-ПТ <9-2)

и величин

N611 II Ml

Mllx И Л .4x11

К г II Hr II

(9.3)

(г = Ь-Ах), (9.4)

Ml Ixl Mxl

к = МПМ+И, (9.5)

к IUIIM+II

(9.6)

1 - ка 1-MIM+I

Определения (9.1) —(9.6) применимы, разумеется, лишь когда соот¬

ветствующие знаменатели отличны от нуля. Величина к в (9.5) называ¬

ется числом обусловленности матрицы А.

Теорема 9.7. Пусть х — нормальное псевдорешение задачи наимень¬

ших квадратов Axstb\ r = b—Ax — соответствующий вектор невязки.

*)в советской литературе приняты термины нормальное решение или нормальное

псевдорешение (смотря по тому, совместна или нет задача Ах = Ь), которые и будут в

дальнейшем использоваться. (Примеч. пер.)

39

Предположим, что WE II \\А+ il < 1 и гапкЛ <гапкЛ, и пусть х + dx - нор¬

мальное псевдорешение задачи наименьших квадратов

А(х + dx)= (А +Е)(х +dx)2ab +db.

Тогда

rank А = rank Л, (9.8)

II Е\\ II х II WdbW

II dx II < \\А

•■(т

-ШМ+1 1-ШЫ+И

II £-11 WA+W II г II

1 - IIi'll 11/П1

Wdx II

+ II Е\\ 1Ы1 , (9.9)

< ка + кур + ккра + ка. < к [(2 + кр) а + 70]. (9.10)

11x11

Доказательство. Равенство (9.8) установлено в теореме 8.15.

Векторы jc и jc + dx выражаются формулами х = A*b i/ix + dx=A* (b+db).

Поэтому

dx = А+ (b +db)-A*b =

= (A* -A*)b+A*db = Gb+A*db.

Заметим, что г = (/ - Q) г = (/ — это вместе с (8.8) дает

G2b = G2r. Из (8.6) — (8.9) следует

dx = -A*Ex + G2r + (/ - Р )ЕтАт*х + A+db. (9.11)

Взяв оценку для ||А* \\ из теоремы 8.15 и оценку (8.26) для ||С2||,

получим неравенство (9.9). Деля это неравенство на || jc || и используя опре¬

деления (9.1)-(9.6), получим неравенство (9.10). Теорема 9.7 доказана.

Заметим, что при п = k = rank Л матрица G3 в (8.9) нулевая, поэтому

четвертый член в правой части неравенств (9.9) и (9.10) равен нулю. Анало¬

гично при m - к = rank А матрица G2 в (8.8) и, следовательно, третий член

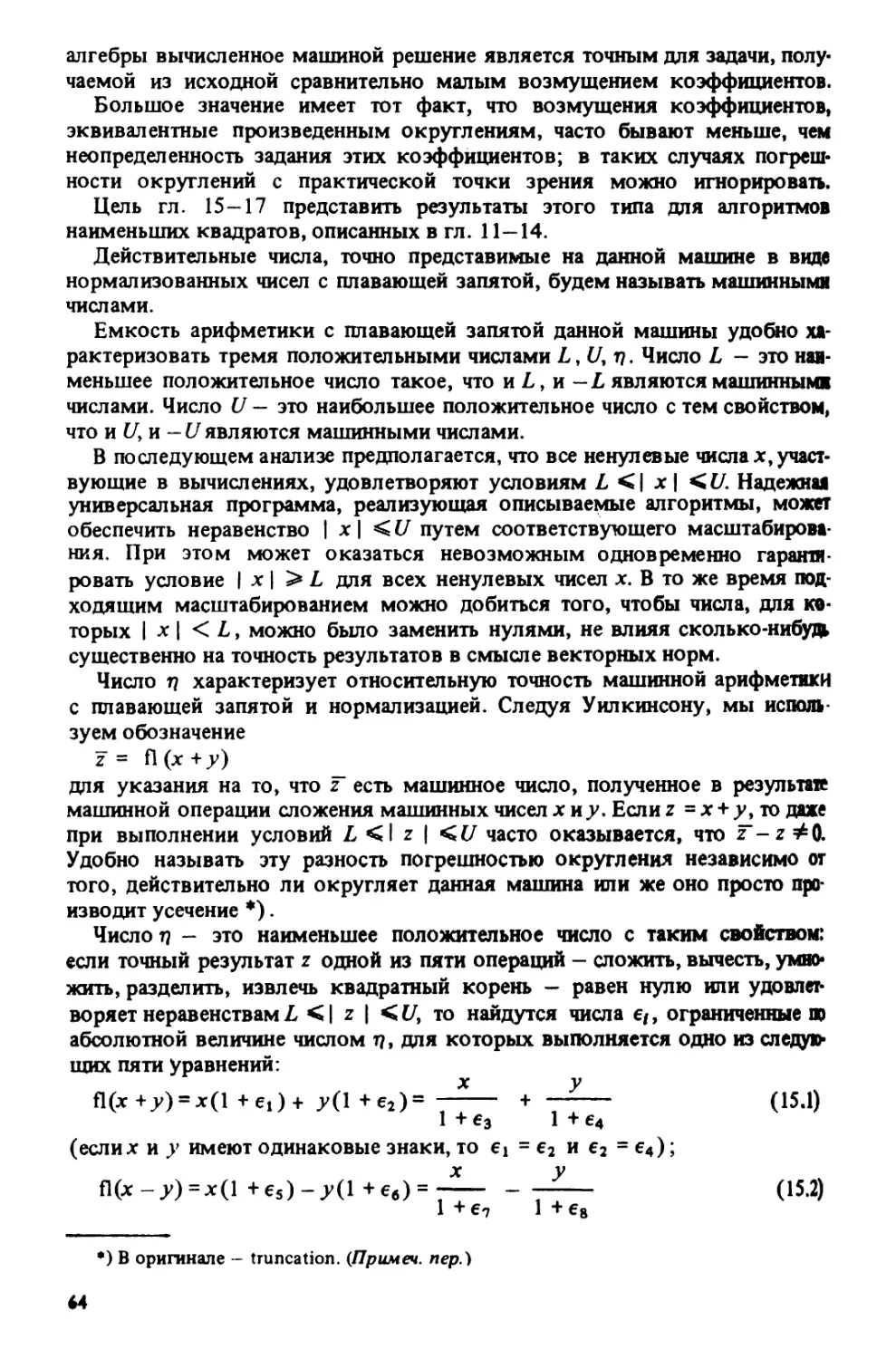

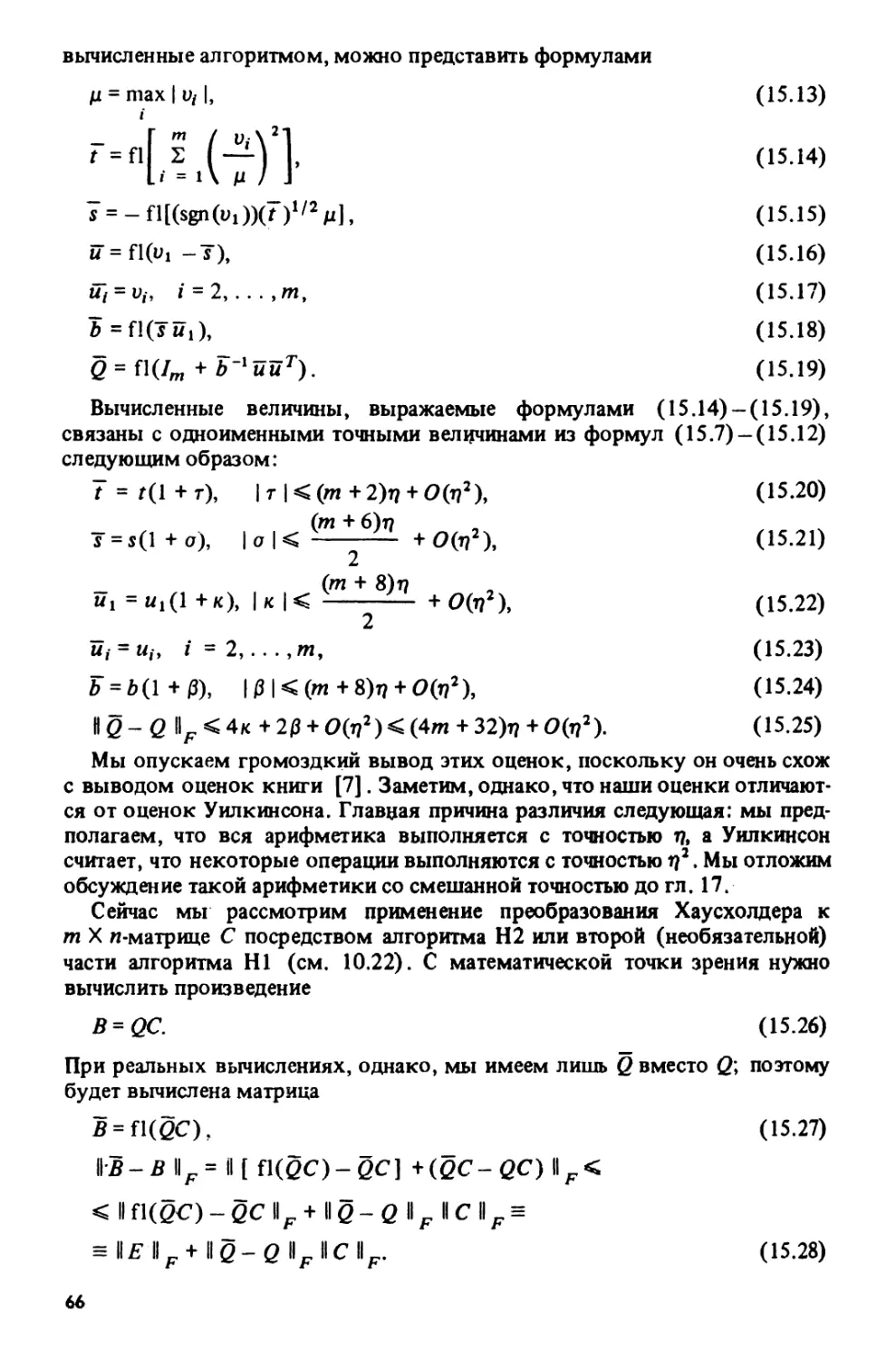

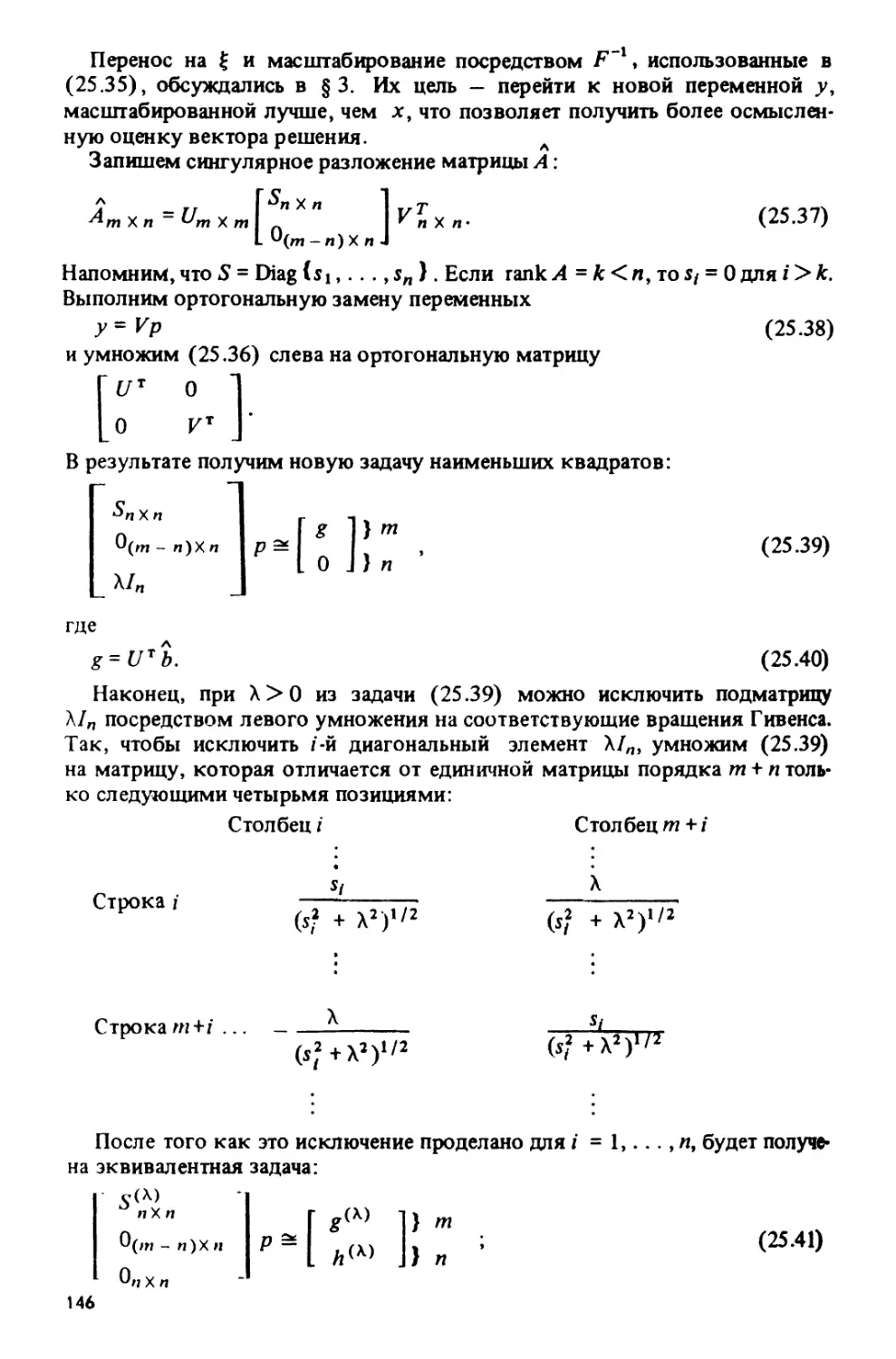

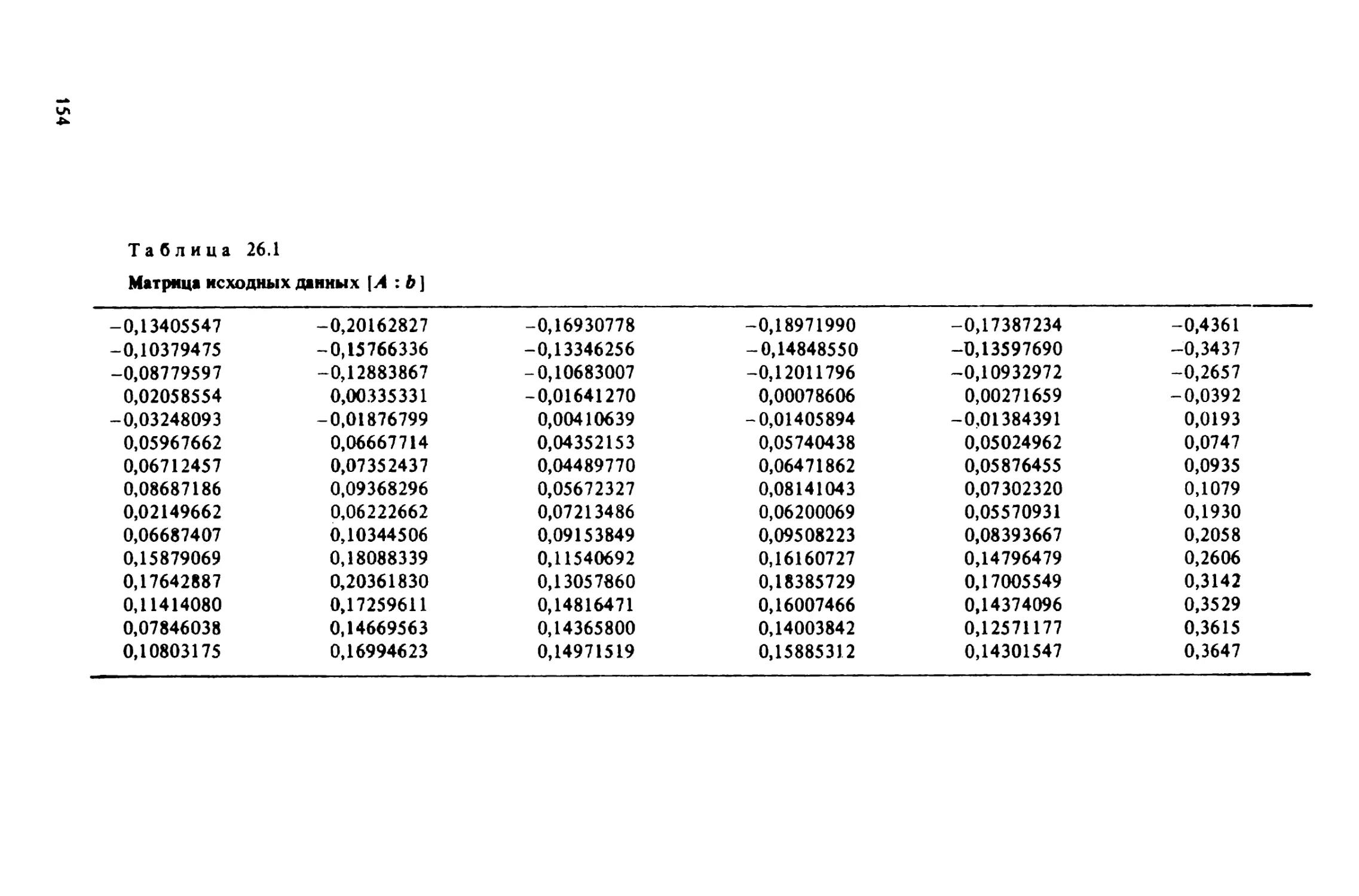

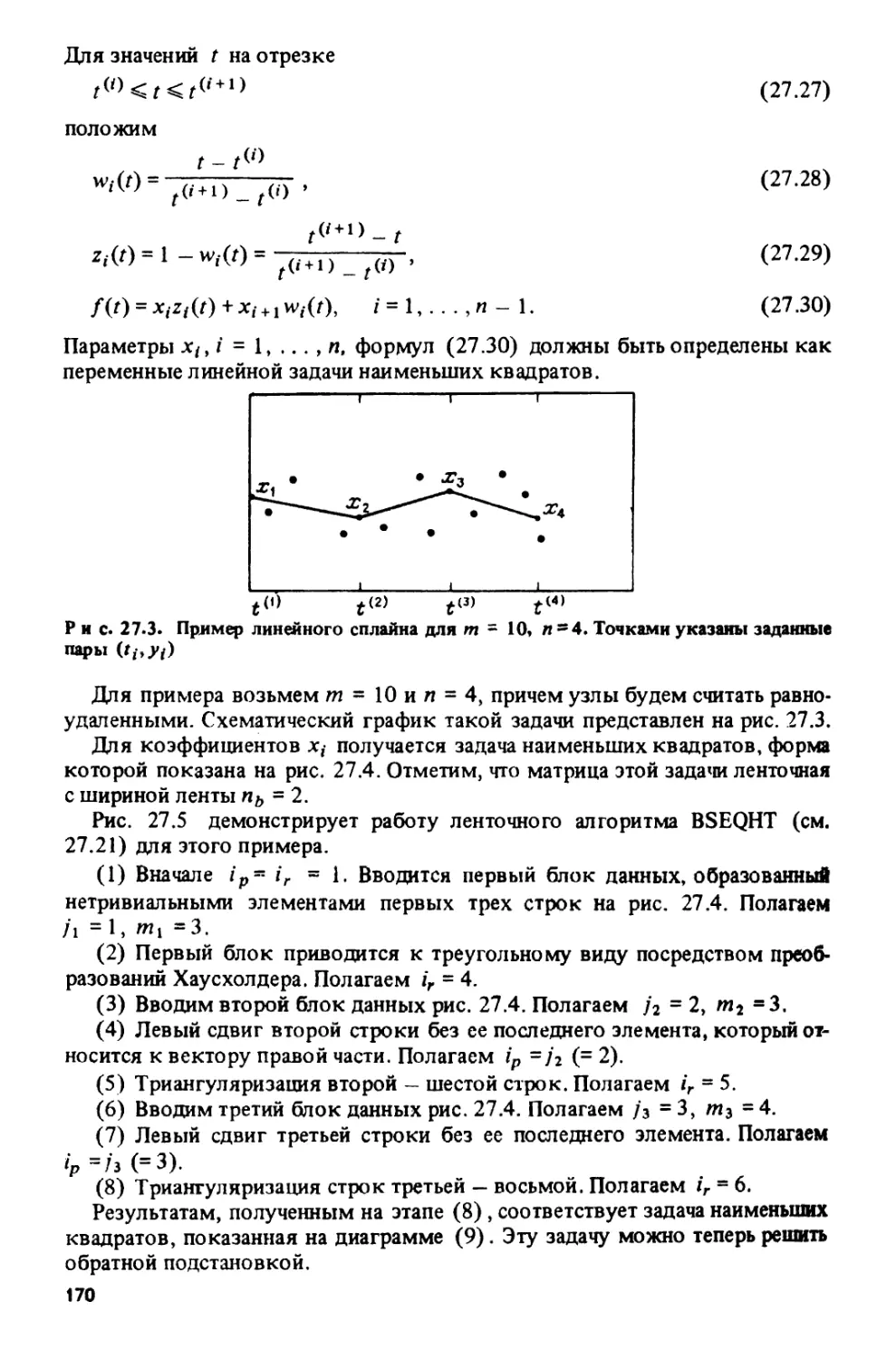

в правой части неравенств (9.9) и (9.10) нулевые.