Текст

У КРАЇ НСЬКА ДЕРЖАВНА АКАДЕМІЯ

* '««“і’ : / ЗАЛІЗНИЧНОГО ТРАНСПОРТУ

о V ФАКУЛЬТЕТ УПРАВЛІННЯ ПРОЦЕСАМИ ПЕРЕВЕЗЕНЬ

І.В.Кова.іішина

ТЕОРІЯ ЙМОВІРНОСТЕЙ

Конспект лекцій

Харків 2004

Ковалі шина І.В. Теорія ймовірностей: Конспект лекіїій-

Харків: УкрДАЗТ, 2004. - Ч. 2. - 69 с.

Конспект лекцій розглянуто та рекомендовано до друку

на засіданні кафедри «Вища математика» 2 лютого 2004 р.,

протокол № 6.

Рецензент

проф. А.А.Янцевич (ХНУ)

ЗМІСТ

Тема 1. важливіші закони розподілу випадкової 5

величини

1.1 Біномний закон розподй 1.2 Теореми Муавра-Лапла і .3 Розподіл Пуассона 1А Геометричний розподіл 1 Показниковий (або екСп 1.6 1 Юрмальний закон розп 1.7 Рівномірний розподіл 1.6 Розподіл функції випади 1.8,1 Закон розподілу Коші 1.8.2 Розподіл / ' 3 ОДНІЄЮ С 1.9 Розподіл Лапласа 1,10 Граничні теореми теорії 1.10.1 Означення ЗбіжНОС ГІ за 1.10.2 Нерівність Чебишева 1.10,3 Закон великих чисел (ЗІ 1.10.4 Застосування ЗВЧ 1.10.5 Центральна гранична те 1.10,6 Відхилення частоти від Тема 2. Випадкові вектс 21 Системи випадкових ве. 2.2 Двовимірний випадкови 2.3 Властивості функції роз 2.4 Дискретні випадкові век 2.5 Закони розподілу коорд вектора 2.6 Неперервні випадкові Ві 2.7 Властивості щільності р 2.8 Числові характеристики 2.9 Моменти випадкового а 2.10 Центральні моменти др Тема 3. Елементи матет 3.1 Про задачі математичні 3.2 Генеральна га вибірков 3.3 Статистичний розподіл 3.4 Емпірична функція розп 3,5 Полігон І гістограма 3.6 Статистичні оцінки пара 3.6.1 Статистичні оцінки парг СІ іу 5 са в 7 10 опенціальний) розподіл 11 оділу (закон Гаусса) 14 19 ;ової величини 21 21 ҐЄПІННЮ ВОЛІ 23 24 ймовірностей 27 ймовірністю 27 28 34) 20 29 зорема Ляпунова (ЦҐЇ) 30 ймовірності. Теорема Бернуллі ЗО >ри 32 пичйн 32 й вектор (;,>/) 32 поділу 33 тори (ДВВ) 35 инат дискретного випадкового Зб актори (НВВ) 37 рзподілу 38 випадкового вектора 40 ектора 40 угого порядку 41 иатичної статистики 43 Я статистики — - 43 а сукупності Ц Цг а 43 вибірки і | 44 оділу 45 метрів розподілу’ '.'а /1 Егж.-*48 метрів розподілу /'Е М1Я 48 Ш11нИЧН <) ґ О ГРАВСЬ У&тіїна, ГІП50, м.ХавкІв, щйдпіи Б т г; я тот V V. ♦

3.6.2 Незсунені, конзистентні оцінки 48

3.6.3 Генеральна середня 49

3.6.4 Вибіркова середня 49

3.6.5 Оцінка генеральної середньої через вибіркову середню. 50

Стійкість вибіркових середніх

3.6.6 Генеральна дисперсія 51

3.6.7 Вибіркова дисперсія 51

3.6.8 Формула для обчислення дисперсії 51

3.6.9 Оцінка генеральної дисперсії 52

3.7 Точкові оцінки; надійна ймовірність (надійність), 54

надійний інтервал

3.8 Кореляційний зв’язок між випадковими величинами. 59

Регресія

3.8.1 Вивчення зв’язку за допомогою прямих регресії 59

3.8.2 Вибіркові характеристики зв’язку 61

3.9 Статистична перевірка статистичних гіпотез 63

3.9.1 Статистична гіпотеза. Нульова і конкуруюча, проста і 63

складена гіпотези

3.9.2 Помилки першого та другого роду 63

3.9.3 Перевірка гіпотези про нормальний розподіл 64

генеральної сукупності за допомогою ексцесу і

асиметрії

3.9.4 Статистичні критерії перевірки нульової гіпотези 67

3.9.5 Критерій згоди Пірсона 67

Список літератури 69

і' -'1

4

ТЕМА 1 ВАЖЛИВІШІ ЗАКОНИ РОЗПОДІЛУ ВИПАДКОВОЇ

ВЕЛИЧИНИ

Розглянемо спочатку закони розподілу дискретних випадкових

величин.

1.1 Біномний закон розподілу

Розглянемо випадкову величину X, яка дорівнює числу появ

події А в „п” незалежних випробуваннях і запишемо для неї ряд

розподілу

X 0 1 2 3 • » к « * « п

р Рп(0) Рп(1) Рп(2) Рп(3) • • • Рп(к) л * • Рп(П)

де Рп(к) обчислюється за формулою Бернуллі

Рп(к)=С„кркчп4<

де р - ймовірність появи події А в одному експерименті;

д - ймовірність протилежної події, тобто Я=1 - р.

Закон розподілу такої випадкової величини називається

біномним.

Назва пов’язана з тим, що ймовірності можливих значень

випадкової величини X виявляються окремими елементами

формули бінома Н’ютона, а саме:

(Я+Р) - я+Спя р + СпЯ р+ ...+ сп я р - 1 - 1,

тобто сума ймовірностей дійсно дорівнює одиниці.

Розглянемо далі числові характеристики біномного розподілу,

тобто Мх , Ох , о- х :

л л

РМ=ї.к с'‘р‘ч’~‘

*-0 і-Н'

о, =л/(№) -[ЛЇ(Л-)]2 = кТ

*-0

Суми у попередніх формулах можна безпосередньо

підрахувати, але простіше зробити так.

Розглянемо сукупність випадкових подій Х1( Х2, , Хп, причому

будемо вважати, що X, - подія, яка полягає в тому, що подія А

з’являється, або не з’являється в і - му випробуванні.

5

Очевидно, для кожної Х| має місце ряд розподілу

Обчислимо математичне сподівання М(Хі) і дисперсію О(Хі):

М(Хі) = 1р + Од = р,

О(Хі) = М(Х,2) -[М(Хі)]2 = 12 р + О2 ч - р2 = р - р2 = р( 1- р ) = рЧ.

Таким чином, усі випадкові величини X; мають однакові

математичні сподівання М(Х,) = р і дисперсії О(ХГ) = рц.

Випадкова величина X, яка дорівнює числу появ події А в „п"

незалежних випробуваннях, дорівнює сумі X = X! + Х2 + ... + Хп,

причому Х-| Х2 , ... , Хп попарно незалежні, тобто:

М(Х) = М(Х0 + М(Х2) + ... + М(ХП) = пр,

О(Х) = ОСХО + О(Х2) + ... + О(ХП) = пря.

Таким чином, числові характеристики біномного розподілу такі:

М(Х) = пр, О(Х) = прд, а{х)=4прц.

1.2 Теореми Муавра - Лапласа

При великих значеннях „п” можна наближено обчислювати

біномні ймовірності за допомогою локальної теореми Муавра -

Лапласа.

Вперше цю теорему отримав Муавр у 1730 році для окремого

випадку схеми Бернуллі при р ~ ц = 1/2 ; пізніше Лаплас узагальнив

її на випадок довільного “р”, відмінного від 0 і 1.

Локальна теорема Муавра - Лапласа

Нехай у кожному з „п” незалежних випробувань ймовірність

настання події А однакова і дорівнює р (0<р<1) , Рп(к) - ймовірність

того, що при „п” випробуваннях подія А настане “к” разів. Тоді:

ПС*)-

** =

к-пр

4^РЯ

Xі

(Функція = - табульована).

72я

6

При розв’язанні практичних задач часто виникає необхідність

обчислення суми виду

^(А), тобто ймовірності того, що подія А

з’явиться в „п” незалежних випробуваннях не менше ніж “к/ разів і

не більше ніж „к2" разів (а, < к < к.) .

Безпосереднє обчислення таких сум навіть при застосуванні

локальної теореми Муавра - Лапласа дуже громіздке. Крім того, при

додаванні великої кількості наближених значень Рп(к) можуть

утворюватися значні похибки.

Такі суми доцільно обчислювати за допомогою теореми,

відомої під назвою інтегральної теореми Муавра - Лапласа.

Інтегральна теорема Муаера - Лапласа

Р (А] <£ р 2 сіх, х, = х

Л \ 1 х / Г— 1 7 І / 1 ± І

№ у/прд ^прд

Зауваження. Розглянемо інтеграл зі змінною верхньою межею

X і *

ф(х)=-71= р'м,

72л-

який називають інтегралом ймовірності. Інтеграл ймовірності ф(х) -

табульований. За його допомогою, інтегральна теорема Муавра -

Лапласа набуває вигляду

РДА, їк^к^ФІх^-ФІХ').

1.3 Розподіл Пуассона

Розглянемо випадкову величину, яка розподілена за біномним

законом і для якої відомо, що число незалежних випробувань «->«>,

а ймовірність „р” появи події А у кожному випробуванні прямує до

нуля

В цьому випадку можна обчислювати біномні ймовірності Рп(к)

за наближеною формулою, яка є наслідком теореми Пуассона,

доведеною при припущенні, що добуток р п = л (А - стала

величина).

7

Теорема Пуассона

Якщо Рп(к) - ймовірність „к” успіхів у серії з „п” випробувань

Бернуллі, в кожному із яких ймовірність успіху дорівнює р - -, то

п

Ьіт . ч Xі з

_ />.(*)=У гл.

—> оо я!

Доведення. За формулою Бернуллі (ц = 1-р)

п-к к А________

пк

1- —

п

ЬітРМ= Ьіп

п

Обчислимо окремо границю кожного множника

л

Ьіт (

Ьіт (

= ГА ;

«У

і

п

Ьіт ( 1 У

—П

Ьіт

п—>£

к\

А* _Л*

п* ”ТЇ

к-\

п

л

2

п

тобто дійсно

Ьіт

Рп(А)=

7 А!

Ряд розподілу Пуассона має вигляд:

X 0 1 2 3 к « V « п 1 •

р гл -г1 1! — 1 л 2! 3! • « л * —Гл *! « • « ,-л —гл п! . - <

Перевіримо умову нормування, тобто підрахуємо суму усіх

ймовірностей

+*Ж: +4Ю /I Л Л1 Лк } я., „і .

УР(к) = ГлУ— = ГЛ 1 + - + — + • + — + •• • =ГЛ £л=\.

к . 1! 2! к\ ,

Числові характеристики розподілу Пуассона такі:

8

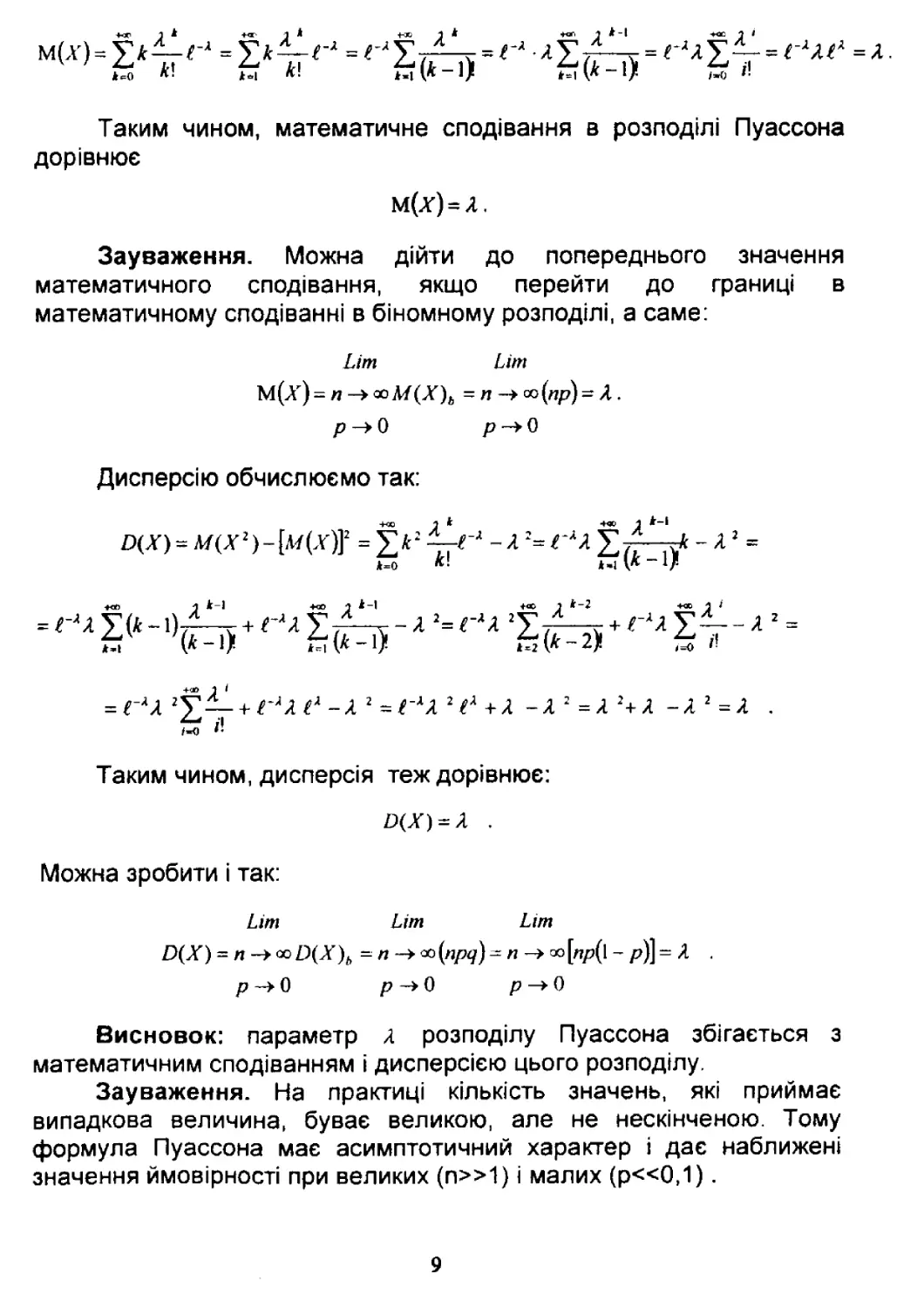

Таким чином, математичне сподівання в розподілі Пуассона

дорівнює

м(х) = л.

Зауваження. Можна дійти до попереднього значення

математичного сподівання, якщо перейти до границі в

математичному сподіванні в біномному розподілі, а саме:

ЬІт Ит

М(%) = п —> ооЛ/(Х)6 - п —> со (ир) ~ Я .

р -> 0 р -> 0

Дисперсію обчислюємо так:

+00 2

Д(.П=л/(А-2)4<ї)]!

2 = ГХЛ2Ґ +Л

-л 2 =л 2+л -л 2 =л .

Таким чином, дисперсія теж дорівнює:

£(%) = Л

Можна зробити і так:

Ьіт Цт Ьіт

О(Х) = п -><х)О(Х)Ь =- л —> - п -> оо[л/?(1 - /?)] - Л

р->0

р^О

Висновок: параметр л розподілу Пуассона збігається з

математичним сподіванням і дисперсією цього розподілу.

Зауваження. На практиці кількість значень, які приймає

випадкова величина, буває великою, але не нескінченою. Тому

формула Пуассона має асимптотичний характер і дає наближені

значення ймовірності при великих (п»1) і малих (р«0,1).

9

1.4 Геометричний розподіл

В задачі Бернуллі (р=Р(А), 0<р<1) розглянемо випадкову

величину X - число випробувань до першої появи події А.

Очевидно, розподіл цієї випадкової величини має вигляд

X 0 1 2 3 • 4 Ч п • 4 4

р _д!е_ .як 4 4 а ЧПР 4 - -

Р(Х = п) = Япр.

Цей розподіл має властивість, яку називають властивістю

відсутності післядії. Ця властивість полягає в тому, що ймовірність

того, що подія А з’явиться у випробуванні з номером „п+т" не

залежить від того, чи з’влялася подія А у випробуваннях з номерами

до “п" включно, тобто

Р(Х=п+т/Х£п) = Р(Х=т).

Дійсно, застосуємо формулу умовної ймовірності

Р(АВ)

Р(В) ’

тобто

)) _ Р(Х ~п + т) _ Р(Х = п + т) _ Р(Х = п + т)

Р(Х^ ї/р

Ьл

РЧ І^ч

к*п

Р(Х = п + т) рсГ” т „.V ч

=——™—і=-42—ї-= р=Р(%=т).

, л X. 1 і 1

РЯ РЧ • -

ТІЇ 1-7

Умова нормування виконується:

4-Х +<Ю 1

=2?*р=р-г—=••

*>о *=о і~Я

Визначимо далі числові характеристики геометричного розподілу:

^(Х)^^Р-±^Р = РЧ^2Ч + Зч2 +’)= ря(я + 42 +<73 +*••) =РЯ ~—

. И -я)

1

= -

тобто

М(Х) = £.

р

10

Дисперсію будемо обчислювати за формулою О(Х)=М(Х2)- [М(Х)]2.

Обчислимо спочатку перший доданок

ЩХ2)^[м(Х2)+М(Х)]-М(Х) = Р + Х^Р ~~

-1 =

Р

*=І

* 1

= 9р(1 2<7° + 3 • 2^ + 4 • 3^г + • )- — = яр^а2

Р

3 4 \" Я

+ Я +<? + • • ) - — -ур

Р

<7

_£ =

Р

1-2ІЛ

р р2 р

Далі,

О(Х) = М(X2)-[Л/(Х)]2 = = 27.Ц*1) = А.

р р р р р

Отже,

0(^=4'

р

Розподіли неперервних випадкових величин

1.5 Показниковий ( або експоненціальний) розподіл

Означення. Неперервна випадкова величина X розподілена за

показниковим законом, якщо її щільність має вигляд

о, /£0

0, Си>0)’

Графік щільності Гх(і) такий:

н

Інтегральна функція розподілу дорівнює

1-Г"'

Таким чином,

і її графік такий:

Зауваження. Показниковий розподіл є неперервним аналогом

геометричного розподілу і єдиний з усіх абсолютно неперервних

випадкових величин задовольняє властивості відсутності післядії,

тобто;

Дійсно, умовна ймовірність дорівнює

/ ) = ^((^>.У + /) (^>5)) = Р(%£5 + /) = р($ +1 <> х <+<х>)

Х>з' Р(Х>з) Р(Х>з) ~ Р(5<Х<+оо)

1-Р(А,<^ + г) _ 1-^(5 + /) = £^21

\-Р(Х<з) ~ І-ГДл) " Г*'

= Р(Хїі).

Розглянемо, чи виконується умова нормування,

тобто чи

+«з

{/(ґ)Л = 1 ?

12

+ оо

4-Х +»

{/(№ = ^ЄІ‘'Ж = І (-Г")=1.

-оо О /і

Обчислимо далі числові характеристики показникового розподілу:

+оо +ао

М(Х) = ^-/(і)аі = =

”00 О

1 1

+ — = —.

Р А

Ьіт ( і \ ] / (л Ьіт ( 1

I * І 1 І/7"Я00 І „

І -> +001 )

Таким чином, математичне сподівання в показниковому

розподілі таке:

Л/(%) = -.

Для обчислення дисперсії застосовуємо формулу 0(Х) = М(Х2)-

[М(Х)]2:

+» +«С

м(х)= р2.до^= =

~ао О

и - і

ау^г^аі

+ 00

= І (-/2Г'"+2рГ'")

О

и^і2

ау^^а^аі

аи — паї

у = -Г"1

аи = аі

V =-----

А

Але тоді

Зауваження. Параметр р показникового розподілу тісно

пов’язаний з математичним сподіванням і дисперсією

Л/(.Г) = - , ОСГ) = -ІТ,

А А

тобто, якщо відомий параметр р, тоді відомий і повністю

показниковий розподіл абсолютно неперервної випадкової величини X.

Показниковий розподіл належить до однопараметричних

розподілів.

13

1.6 Нормальний закон розподілу ( закон Гаусса)

Означення. Нормально розподіленою випадковою величиною

з параметрами а,а називають абсолютно неперервну випадкову

величину X, яка має щільність розподілу

З’ясуємо імовірнісний зміст параметрів а І сг, для чого

обчислимо математичне сподівання М(Х) і дисперсію О(Х).

Але спочатку перевіримо,що виконується умова нормування

|/(л)Л = 1.

Останній інтеграл обчислимо так: розглянемо подвійний

інтеграл по всій площині ХО¥

Х2+уг +<ю Xі +аа уг / +оо Xі 'У

2 <Шу= р р2^ .

хог - І- >

З іншого боку, переходячи до полярних координат, обчислюємо

подвійний інтеграл, а саме:

2х

2

2 Г(ІГ

хог

о

ХОї

о

о

Тобто

2

- 2л

2л.

Таким чином, умова нормування виконується

14

Обчислюємо математичне сподівання

Л/(X) - їх/(х)сіх - .—— їх(, 2а (іх = ~у=— ії(х - а) + а] € 2<т (їх =

72л- <г^ 72я-а_і

(Ми використали той факт, що в попередньому виразі перший

доданок дорівнює нулю, як інтеграл в симетричних границях від

непарної функції).

Таким чином, параметр а є математичним сподіванням

М(Х) = а.

Далі обчислюємо дисперсію

й(Х)= |(л-а)7(*)Л =

2 П Х~а

2

С 2сг2

х-а

— -і

---- = (її

СГ

са

. +00 ї1

=сг2 р2£ 2 сії.

2л і

Останній інтеграл

частинами, а саме:

інтегруємо за

формулою

інтегрування

2 +«> Iі

£= р2 П(іі =

2л І

<1и = (її

<іу = і£ 2 <11

У = ~? 2

2л

-а 2

— ОО

2- • 72я-= а 2

/2л

и = і

2

тобто

О(Х) =

Отже, з’ясовано теоретико-ймовірнісний зміст параметрів

а, (у : а є математичним сподіванням, о2 - дисперсією, а о- -

середнім квадратичним відхиленням випадкової величини,

розподіленої за нормальним законом.

Таким чином, нормальний закон розподілу повністю

визначається своїм математичним сподіванням і дисперсією.

Інтегральна функція нормального закону дорівнює

15

ДЄ

1-а

----= г

а

X

г

х - а

інтеграл ймовірності.

Ймовірність попадання випадкової величини X в інтервал (а.д)

можна обчислити за формулою

або

Р(а< X < Р) = Е(Р)-/4*).

Р(а<Х < Д) = Ф‘ґ —- а -а\ - Ф

Нормальна крива ( крива Гаусса)

Означення. Графік щільності ймовірності нормального закону

розподілу називають нормальною кривою ( кривою Гаусса).

Досліджуємо функцію

методами диференціального числення:

1) функція „у” визначена на усій числовій осі і приймає тільки

додатні значення, тобто нормальна крива розташована над віссю ОХ;

2) Ііт у = о,тобто вісь ОХ є горизонтальною асимптотою

дг —> ±со

нормальної кривої;

3) знайдемо екстремум функції. Для цього обчислимо похідну

। І< т-оУ “

-7=1----£ А * ) .

у12тГ (7

1

2а 3

•2(л-а)

(*-д)

16

тобто критичною точкою буде х = а. Зліва від цієї точки у > о, тобто

функція монотонно зростає, справа - у<о і функція монотонно

спадає. Таким чином, в точці х = а функція „у” має максимум і

і

у/?л а

4) далі, за допомогою похідної другого порядку знайдемо

інтервали опуклості, угнутості і точки перегину нормальної кривої

-=!—-(х2-2ах + а2 -<г 2)~-=!—Г[х-(а + сг)] [х-(а-а)],

72^ <7 у/2ка

тобто Критичними точками другого роду є ху-а-а, х2=а + а .

Саме в цих точках нормальна крива має перегин.

Розглянемо далі вплив параметрів розподілу на форму

нормальної кривої:

а) нормальна крива симетрична відносно вертикальної прямої,

яка проходить через точку х=а; крім того, графіки ї(х) і ї(х-а) мають

однакову форму, тому математичне сподівання М(Х) = а впливає

тільки на місце центра симетрії, тобто на зсув нормальної кривої

увздовж осі ОХ;

б) висота біля кола Н = -т=Д— і тому зміна о- впливає на

у/Зя <7

форму кривої, а саме графік спускається від максимуму тим крутіше,

чим менше а ( загальна площа нескінченної трапеції завжди

дорівнює одиниці).

УКРАЇНСЬКА ДЕРЖАВНА

АКАДЕМІЯ

П А Тї Т Ч її їли Т4 О ГП ТР А ЛГПЛ РТ

ь Зокрема, ймовірність того, що X набуде значення з відрізка

[а-є ,а + є ], ТИМ 6ІЛБШЄ, ЧИМ МЄНШЄ а , ТОбТО ЧИМ МЄНШЗ ДИСПврСІЯ.

Отже, дисперсія нормально розподіленої випадкової величини

справді характеризує степінь розсіяння значень цієї величини.

Зауваження. Обчислимо ймовірність того, що X набуде

значення З відрізка [а-/сг ,а + /0-], ТОбТО |А'-а|<ґст ((>0-довільне). Ця

ймовірність дорівнює

х-а

= ф'(і )-ф’(-г ) = 2Ф(г),

де Ф(/)=-= - інтеграл ймовірності ( функція Лапласа).

чїя о

Покладаючись в останній рівності послідовно, що І =1, 2, 3, за

допомогою таблиці функції Лапласа отримаємо:

Р^Х -а\^а )= 2Ф(1)« 0,68,

Р^Х - а| < 2сг )= 2Ф(2 ) * 0,95,

/>(|X - а| < Зет) = 2Ф(3 ) « 0,997.

Число 0,997 мало відрізняється від одиниці, тому подію з

ймовірністю 0,997 можна вважати практично вірогідною, і останню

рівність часто формулюють у вигляді так званого „правила трьох

сигм”: практично вірогідно, що нормально розподілена

випадкова величина X може відхилятися від свого

математичного сподівання М(Х) = а не більше, ніж на потроєне

середнє квадратичне відхилення.

Властивості функціїЛапласа

Властивості функції Лапласа (інтеграла ймовірності) можна

і

дуже просто дослідити за допомогою графіка функції у = -=г 2

18

Функція Ф(ґ)=-т== - є площею заштрихованої криволінійної

72*'

трапецїі:

1) ф(_/) =ґ<2л = -_1я=р"2л = -ф(/),тобто

л/2я о >/2д-

ф(-г) = -ф(/) - непарна функція ;

2) ф(+оо) = 1 ;

з) ф‘(')=-т== Р’2а=ф(0+| ;

№ л 2

4) ф(/) - табульована.

1.7 Рівномірний розподіл

Означення. Абсолютно неперервна випадкова величина X

розподілена за рівномірним розподілом, якщо її щільність має

вигляд

1

/(х) = Ь - а

0

X е [а , б]

х Є [а , б]

Очевидно, /(х)>0 і виконується умова нормування

•Ь-а о-а,

19

Графік щільності має вигляд

Інтегральна функція розподілу дорівнює

[ 0

] х~а

о~а

1

-оо <х < и

а< х <Ь

І <Л < 4-00

і має графік

Обчислимо далі ймовірність попадання в інтервал (а, //); якщо

цей інтервал належить сегменту [а , Ь] .тоді

тобто ймовірність події (а<х<р) не залежить від

розташування інтервалу («, д)є , а залежить лише від довжини

цього інтервалу.

Знайдемо математичне сподівання М(Х):

ь

М(Х) = ^х/(х)<1х=

о

1 Ь2 -а2 ___ а + Ь

2 ‘ Ь-а ~ 2

20

Дисперсія X дорівнює

й(Х) = М(Х2)-М2(Х) = |х2/(х)Л-

I 2 )

1 । х3 ґа + ^у_63-а3 (а + дУ _ Ь2 + аЬ + а2 а2+2аЬ +Ьг _ а2 + Ь2-2аЬ

2 ) 3(Ь-а) І 2

Ь-а З

(Р~а)2

Таким чином, числові характеристики рівномірного розподілу

такі:

М(Х) =а+Ь/2, Р(Х) = (Ь-а)УІг

1.8 Розподіл функції випадкової величини

Нехай X і У — випадкові величини, пов’язані між собою

функціональною залежністю У = Ї(Х) і нехай закон розподілу X

відомий, а саме відомі гх (х), /х (х) = нх (х).

Виникає питання: як знайти закон розподілу функції У = Ї(Х) ?

1.8.1 Закон розподілу Коші

Нехай <р - випадкова величина, рівномірно розподілена на

інтервалі

Розглянемо нову випадкову величину

У=аІ&<р .

Графік щільності випадкової величини <р і геометричний

зв’язок між (р і У наведені далі:

21

Очевидно,

агсі% - = Е агсі% - .

а) І а)

а)

Таким чином, інтегральна функція розподілу дорівнює

(х) = Л* агсі£ - .

І а)

Знайдемо далі щільність ймовірності

тобто щільність (або диференціальна функція розподілу) в розподілі

Коші така

Рг(х} = Г г

я (а +х )

22

Обчислимо математичне сподівання цього розподілу

0 + оо

+« -ню

Щї) = (х\іх = [—І —Іп(х2+а2)+ І — 1п(х2+а2)->оо ,

І .іЛ (а +х ) 2л 2л

тобто числові характеристики в законі Коші такі:

Л/(Г) = + оо, 0(Г) = +оо.

1.8.2 Розподіл х 2 з однією стелінню волі

Так називається випадкова величина, яка дорівнює

/2=А'2,

де X - стандартна нормальна випадкова величина з М(Х) =0 і

дисперсією О(Х) = 1, тобто

/(%) = х2.

Знайдемо

<,*(*)> РхАХУ

л > 0 _ р(- 4х < X < 4х\ л > 0

х < 0 0, х < 0

< Ех (Тл)- Ех (- т/х), л > 0

0, х<0*

а

тобто

23

Обчислимо математичне сподівання та дисперсію:

=ЗМ(^2)-1 = 3-1 = 2.

<2л- І

Таким чином, числові характеристики в цьому розподілі такі:

а/(/1 2 3 4) = і; ^(/>2.

1.9 Розподіл Лапласа

Означення. Випадкова величина X розподілена за законом

Лапласа, якщо її щільність така:

рх (х) = , (Л > 0).

Задача дослідження цього розподілу формулюється так.

Треба:

1) визначити коефіцієнт „а”;

2) побудувати графік щільності ймовірності рх(х);

3) визначити інтегральну функцію розподілу Ех(х) і

побудувати її графік;

4) знайти математичне сподівання І\Л(Х) і дисперсію О(Х).

24

Для визначення сталої „а” застосуємо умову нормування

(ра (*№ =1:

-оо

, 7 °Г^ 1° Г*1 Ґ1 ГЙ /г“ Н 2а

1 = Іа£ ! 'сіх = а и сіх + а н А сіх ~ а------------------------а -----------~ а------------------ а —---------- ~ —

о Л [Л Л } І Л ЛІ Л

-«1 -СО 0 Л X 7 \ >

Таким чином, розподіл Лапласа має вигляд:

рх (*)=у ^Л|ї!» и > о)

Визначимо далі інтегральну функцію розподілу за формулою

рх(х)= ІРх(№-

Якщо -оо<х<0

?х(х)= |

7 12 2і 2у 7 2

-00

ЯКЩО 0<Х<+ао

25

о

2 І

о

1 =1_І£-^ + 1

2 2 2 2

0

1 •

Таким чином, інтегральна функція розподілу Лапласа така

2

1-1 ГЛг

2

Графік інтегральної функції розподілу має вигляд:

Обчислимо математичне сподівання і дисперсію:

О

О

сіх = -<іі

о

І 2

1 2

о

тобто

М(Х) = 0.

Для обчислення дисперсії застосуємо формулу

О(Х) = М(Х2)- [М(Х)]2:

26

+* о і и-хг(1и~ 2хЛх

О(Х)=М(Х>) = Р>х(х>&= рг^4'Л+ рт<''Л=А = ги.4 , =

-<ю -в 0 і

Отже,

Л/(Х) = 0, О(Х) = ^Т.

л>

1.10 Граничні теореми теорії ймовірностей

1.10.1 Означення збіжності за ймовірністю

Нехай Х2, ... , Хп, ... нескінченна послідовність випадкових

величин.

Якщо для будь-якого додатного є > о

р(|уя-а|>г )->0 при умові, ЩО л->+юо,

тоді кажуть, що послідовність {Хп} збігається за ймовірністю до

невипадково! величини а і позначають цей факт так

Х„ -+а за ймовірністю,

або

кіт

Хп~а за ймовірністю.

п 00

27

1.10.2 Нерівність Чебишева

РІ\Х (?£>о)

Є

Доведення: Нехай X - випадкова величина, М(Х) - її

математичне сподівання. Оберемо Уг>о і побудуємо на числовій

осі ОХ інтервал (М(Х) - є, м(Х) + є )

М(Х)-£ М(Х) М(Х)+£

Позначимо через Ох множину тих их”, для ЯКИХ рГ-Л/(Х)|>* .

Обчислимо дисперсію

О(Х) = |(л - М(Х))2 рх(х\ік > |(.г - М(X))2рх(х)сІх £ є 2 ^рх(л)^х = є 2Р(Х еОх) =

•н» ох йх

= Е ’/фґ - М(Л")| > е\

тобто

й(Х) £ є 2Р§Х - Л/(А')| > о),

або

р^х-м(х'\>е'}<,!^р.

Є

1.10.3 Закон великих чисел (ЗВЧ) ( Чебишев, Хінчин)

Нехай Х1( Х2, ... , Хп, ... - послідовність однаково розподілених

випадкових величин, причому л/(А\)-«, о(Хк)< + ™. Тоді середнє

арифметичне збігається за ймовірністю до числа а, тобто

28

Доведення. Застосуємо нерівність Чебишева для середнього

арифметичного

і, якщо

п -> +00

Р(Х)

пє 2

тобто

п ->+<».

1.10.4 Застосування ЗВЧ

Нехай відбувається вимірювання деякої величини. Тоді, як

наближене значення цієї величини, згідно з ЗВЧ, треба

використовувати середнє арифметичне спостережених значень.

Дійсно, якщо розглядати спостережені значення як випадкові

величини Хі, Х2,... , Хп з рівними математичними сподіваннями М(Хк)

= а і дисперсіями £)(Л\)< + <ю, причому М(Хк)=а - дійсне значення

вимірюваної величини, ми, за ЗВЧ, отримаємо, що середнє

арифметичне збігається за ймовірністю до „а”

—!---2--------~>а, п-ї+ао 33 ЙМОВІРНІСТЮ,

п

тобто, ЯКЩО п>>1, то

я а . за ймовірністю,

п

якщо немає систематичних похибок.

29

1.10. 5 Центральна гранична теорема Ляпунова (ЦГТ)

Нехай Хь Х21 ... ,Хп - послідовність незалежних випадкових

величин.

Розглянемо суму

і введемо нормовану випадкову величину

Тоді для будь-якого „х” функція розподілу

або

/Г [Гчі.

Зауваження 1. ЦГТ стверджує, якщо деякий процес є

сумарною дією множини незалежних випадкових величин, то його

розподіл мало відрізняється від нормального, тобто теоретично

доводить важливість і розповсюдженість у природі нормального

розподілу.

Зауваження 2. Локальна і інтегральна теореми Мавра -

Лапласа є прикладами застосування ЦГТ.

1.10. 6 Відхилення частоти від ймовірності.

Теорема Бернуллі

Нехай д„- число появ події А в „п” випробуваннях Бернуллі;

_ частота появи події А; р = Р(а) - ймовірність появи події А

в одному випробуванні.

Якою буде ймовірність того, що відхилення частоти Ґл від

ймовірності „р” не перевищує V є > о

зо

Розглянемо цю ймовірність

— < р + є

п

< пр+пє) = Р(к} <,рв<к2),

ДЄ к{ - пр-пє, к2 = пр + пє .

За інтегральною теоремою Муавра - Лапласа,

к} - прУ

4прд ?

Пр 4- ПЄ - Пр

( А

пр- пє- пр

<р

= Ф

Таким чином, має місце співвідношення

р(рл-р|<£)=2Ф

із якого випливає формула і теорема Бернуллі:

ДІЙСНО, ЯКЩО «—>+00, тоді Ф є

Зауваження. Теорема Бернуллі підтверджує визначення

ймовірності за Мізесом

Р(^) =

Ьіт р ,

« -> оо п

31

ТЕМА 2. ВИПАДКОВІ ВЕКТОРИ

2.1 Системи випадкових величин

В теорії ймовірностей і математичній статистиці часто

зустрічається ситуація, коли декілька випадкових величин пов’язані

між собою.

Означення, п - вимірним випадковим вектором (або системою

„л” випадкових величин) називається вектор

І2.

всі координати якого є випадковими величинами, визначеними на

загальному просторі елементарних подій деякого експерименту

( усі з’являються в одному експерименті)

Приклад. Підкидаються разом 3 гральних кубики. Розглянемо

випадкові величини:

- число очок, які випали на першому кубику;

£2 - сума числа очок на усіх кубиках ;

£ - найбільше число очок.

?(<,.£,£)

тривимірний випадковий вектор заданий на просторі елементарних

подій о, який складається з п = б3 елементарних подій.

Розглянемо усе більш детально.

2.2 Двовимірний випадковий вектор (<, //)

Означення. Розглянемо довільну точку М(х, у) на площині і

подію, яка полягає в тому, що

(£ < л ; 7? < у)

Функцією розподілу випадкового вектора (£,?}) називається

' ймовірність такої події:

= <хл<у)

32

Геометричний зміст функції розподілу полягає в тому, що

Рії(х’У) - ймовірність того, що випадкова точка (£,;/) міститься у

нескінченному прямокутнику з вершиною в точці М(х, у)

М(х,у)

2.3 Властивості функції розподілу гіч(х,у)

1) О&РьІх.у)^-,

2) Г^(-<ю,у)*0; Е^(х ,-«>)= 0, ТОМУ ЩО ПОДІЇ £<-<», т/с-оо

неможливі, тому І сумісні ПОДІЇ ($ <-°о ,п< у), (£ <X , 7/ < -оо) Є ПОДІЯМИ

неможливими , і тому їх ймовірності дорівнюють нулю;

3) Л,(+оо,+оо)=1.

Події £< + оо, ^< + оо - ВІрОГІДНІ, а ТОМу І ПОДІЯ (£ < 4-оо , т] < 4- оо)

вірогідна.

4) > у) ‘ Функція неопадна за кожним з аргументів, а саме:

а) V х, >х2 .хі<х2=> г(х} , г) < г(х2 ,у);

в) V У, «У2 : У, < у2 => г(х ,Уї) < Е(х ,у2);

доведемо випадок а). Розглянемо на площині дві точки М(хьу) і

М(Х2,У) І ТрИ ПОДІЇ (£<х]гц<у), (<* <х2 ,/}< у), (*! <£<л2 ,п<у)

Очевидно, справедлива рівність

зз

-1' (£ <х2-,ї] <у)=-({ <х};т]< у) + (*і ^<х2,л<у) ,

< к . .-

чому доданки справа несумісні. Але тоді

Р(ь <хг\т]< у) = р(^ <хх\Т!<у)-¥Р(хі <^<ХІ,Г]<у) . (*)

Маючи на увазі співвідношення

Р(* < х2\7 < >)= р\х2, у); р(% <хї;гі< у)=р(хі;у); ф, < х2; /?<>)> 0,

отримуємо потрібну нерівність

Р(х} -у)^Р(х2\у) .

Випадок в) доводиться аналогічно.

Зауваження. Співвідношення (*) допомагає сформулювати ще

одне правило.

Ймовірність попадання випадкової точки у смугу, яка

паралельна осі О¥, дорівнює різниці значень сумісної функції

розподілу на кінцях смуги

р(л, <{<х2 ,ц<у)=Г(хг,у)-Р'(х1 «Д

Аналогічно можна знайти ймовірність попадання випадкової

точки и, г;) у смугу паралельну осі ОХ:

р(ї<х,ух ^п<уї)^ РІх ,уг)~ Г(х,ух).

а також ймовірність попадання випадкової точки (£ л) У прямокутник

Г(х, < £ < х2 ; у, < т? < у2) = [^(х2, у2) - г(х,, у2)] - [/<(х2, у, )-/(*,, .у,)];

5) функції розподілу координат випадкового

вектора^ л):^(х),г, (у):

Г{(х) = Р(£<х) = ?(^<х л <+«) = ^(х, + оо),

^6’) = р(ч <у)= Р(£ <+<»;/?< >’) = РІГ)(+^, у);

6) якщо випадкові величини т] незалежні, тоді

незалежними будуть і події < х, ?? < у, а тоді ймовірність їх сумісної

появи дорівнює добутку їх ймовірностей

р(^ < X ,П<у)= РІ5 < х) р(ї! < .у)»

34

тобто

ЛМ-

2.4 Дискретні випадкові вектори (ДВВ)

Означення. ДВВ називають випадковий вектор, координати

якого виявляються дискретними випадковими величинами

І?: Уі.У2> " Л

Зауваження. Із цього означення випливає, що множина

значень, які приймає випадковий вектор (або випадкова точка), є

множиною ізольованих точок площини.

Закон розподілу дискретного випадкового вектора має

вигляд таблиці з двома входами, де введені такі позначення:

Р* =Р^ = х,;^ = У/)

л Уі У2 * * * Уп

Х1 Р11 Рі2 * Рт

Х2 Р21 Р22 в а Р2п

» « • • *

Хщ Рт1 Рт2 * * цртп

Очевидно,

Р.=^ - Л

Приклад. Підкидаємо 2 монети. Будемо вважати, якщо випав

герб - це 1, якщо - цифра - це 0. Розглянемо випадковий вектор

(•;,/?) .де

£ - число очок на першій монеті,

ц - сума числа очок на обох монетах.

Побудуємо закон розподілу (5.7)

7/ Л 0 1 2

0 1/4 1/4 0

1 0 1/4 1/4

Усі рі£ 0 і їх сума дорівнює одиниці £р,} = і.

35

2.5 Закони розподілу координат дискретного

випадкового вектора (МоргинальнІ розподіли)

Нехай (£,?)-ДВВ. Визначимо Рі = р($ = Хі), Р.=р^ = у.\

Розглянемо подію £ = Очевидно, ця подія відбувається

одночасно з однією з подій Р = У., тобто

(£ = = = */)•(? = У:)+•' + (£ = *>)• (7 = к)-

За теоремою додавання ймовірностей несумісних подій, отримуємо

Рі ~РІ'+РІ2+"- + РІЯ =1^Рч

7-І

Аналогічно,

Р, = = ^)= = У1)+ р{^ *2’П = Уу)+- + Р^ = хт^ = ГУ)=Е^ •

і=і

Таким чином,

п

(?) р.=^р,г, (2.1)

7-1

(?) Р)^р<]-

и-І

?/ /$ У1 У2 . в . Уп 5

Хі Р11 Р12 Ріп ХРч і

х2 Р21 Р22 • • • р2п і

. . • в • Ь * а а а • *

Х(П Рті Рт2 а • Ртп і

7 Еа. і ХР>2 І • ЕРй /

Приклад. Знайти закони розподілу координат ДВВ, якщо його

закон розподілу має вигляд

36

т/ /< -1 0 ь

1 0,2 0,1 0,3

2 0,3 0,1 0,4

3 0,1 0,2 0,3

0,6 0,4

Координати ДВВ такі:

£ 1 2 3

Р 0,3 0,4 0,3

Зауваження. Якщо координати ДВВ незалежні, тоді

Ру = Нь = ХЛП = Уу)= Р(ї = *,)• = ?;•)= А •

Формули (2.1), (2.2) мають вигляд

л ^Рі'Р^р^р^Р'^^Рі *

У=1 У=1

Д _д д

Р,=2>#=2><Р/=РУ2>=Р,> = Р,-

1=1 1=1 1=1

2.6 Неперервні випадкові вектори (НВВ)

Означення 1. Вектор ,п) називається неперервним, якщо

його координати виявляються неперервними випадковими

величинами.

Між неперервних векторів будемо розглядати лише

абсолютно неперервні, тобто такі, для яких існує щільність

розподілу ймовірностей.

Означення 2. Нехай у площині (яка розглядається як

двовимірний простір Я2) задана деяка область □. Невід'ємна

функція р^(л,у)>о називається щільністю розподілу

ймовірності випадкового вектора якщо ймовірність події

(£ ,7)є о (я є я2) визначається рівністю

37

Р((£ , 7 ) є О) = (х , у}іхс1у .

о

2.7 Властивості щільності розподілу

1) Р(х, У) а о ;

2) . уУіхсіу = 1

я2

(інтеграл по всій площині К2 треба розглядати як невласний)

Яр(х > У^У = р » уУу

Л2 .-00

3) Зв’язок між Р(х,у) і р(х,у) випливає із геометричного змісту

Дійсно,

дР^'УУ

ОХ

д2р(х ,у) _ _

дхду ду V дх 7

38

5) відшукання щільності розподілу координат випадкового

вектора.

Нехай (с.??) - випадковий вектор, ріп(х,у) - його щільність

розподілу ймовірностей. Якими будуть рАхУ? А/М?

+00

X +®

№ \РЇЛ1’3№

\~<Ю -НЗД у

тобто

рАх)=

аналогічно,

рпМ= ]р&('’у№-

Щільності розподілу ймовірностей координат випадкового

вектора

рДД рМ

називаються моргинальними щільностями;

6) розподіл випадкового вектора із незалежними координатами.

Функція розподілу зараз має вигляд

(л ,^) = р(£ < х ; і] < у) = Р(% < х)Р& <у)=К (х) ЛМ *

Але тоді

р, (х іУ)=-і-(е мл м)І=-коо-м*))==р.МлИ.

дхду аДдх М А ду 1 дх М 7 ду дх Л 7 п

Таким чином,

рІГІ(х >у)= Р*(х) ’Р&У

39

: > і 2.8 Числові характеристики випадкового вектора

Нехай (< л) - випадковий вектор.

Теорема. Нехай випадкова величина г = Тоді

математичне сподівання функції двох змінних визначається за

правилом

для дискретної випадкової величини (ДВВ) і

А/(2) = ]]/(х,у)р&

£

для неперервної випадкової величини (НВВ).

Приклад. Нехай ? = £ . Обчислимо математичне сподівання

Означення. Математичним сподіванням випадкового вектора

(£,?) (або центром його розсіювання), називається невипадковий

вектор (М(П^(?)). де

2.9 Моменти випадкового вектора

Означення 1. Початковим моментом порядку „ї+к"

двовимірного вектора (£,??) називається математичне сподівання

добутку }-го степеня координати £ на к_-ту степінь координати ту,

тобто

(іншими словами, якщо ? = тоді початковий момент дорівнює

= М(г)).

40

Означення 2. Центральним моментом порядку л+к”

випадкового вектора (£,7) називається математичне сподівання

добутку го степеня відхилення координати £ від її математичного

сподівання на к -ту степінь відхилення координати 7 від її

математичного сподівання

Ау,=М^-М^)У (7-М(?))*] .

Початкових моментів першого порядку всього два:

=м(^°-71)=м(7?)’ Ио = м(ь’ 77°) = М(7),

вони збігаються з математичними сподіваннями координат

випадкового вектора.

Центральні моменти першого порядку дорівнюють нулю.

Дійсно,

цт = - М(7)“ (п - М(7)' ] = м(7 - М(7)) = М(?)- М(?) = 0,

ию = м[(< - м(7)‘ (7 - м« ]= М(£ - м(7) = м(7- м(7=о.

2.10 Центральні моменти другого порядку

Иаг = м[(; - м(7)“ (? - М« ] = - М(,))2 ] = о(7,

а» = іф - м(=))! (, . мЬ)У]= м[(£ - М(7)2 ]= 0(7,

А,, = м[и - м(7У • (7 - м(г;))' ].

З цих формул випливає, що дІ2, //20 визначають характеристики

окремих координат випадкового вектора.

Але числові характеристики окремих координат вектора ще не

визначають поведінки випадкового вектора в цілому.

Для характеристики випадкового вектора як єдиної системи

необхідно враховувати і зв’язки, які існують між його координатами.

Цей зв’язок визначається третім центральним моментом

другого порядку, а саме:

А, = М[(£-М(7)(7-М(7)].

41

Означення 3. Другий центральний момент другого порядку

випадкового вектора (*,?,) називається коваріацією

випадкового вектора, або кореляційним моментом випадкового

вектора

= м[£ - м(<))- (ті - м(/?))] = Со»(;,>?) = .

к(^л)= "

Зауваження. Другі центральні моменти випадкового вектора

утворюють матрицю другого порядку

£>(£) Со^лУї V

....../X'/) ) Кп/

Означення 4. Правило обчислення коваріації випливає із її

означення

, п) = м[(* - м(^)) (і? - М(?))] = м[<г 7 - £ мОО - м(<)- п + м(е) м(„)]=

= М(<-7)-М(£)М(7)

Таким чином,

к,, =М*л)= м(*л)-м(£)м(7).

Зауваження. У випадку багатовимірного вектора £(^,£2, •••>£,)

кореляційною (коваріаційною) матрицею називається матриця,

елементи якої виявляються кореляційними моментами кожної пари

координат

X кІ2 - к./

К= /с21 к22 ... К2Я

£3 зд яз «

кя2 -

\ пі Ні лл /

42

ТЕМА 3. ЕЛЕМЕНТИ МАТЕМАТИЧНОЇ СТАТИСТИКИ

3.1 Про задачі математичної статистики

В теорії ймовірностей вивчаються різні поняття, пов’язані з

випадковими подіями і випадковими величинами; найважливіші з

них - це поняття ймовірності, функції розподілу, математичного

сподівання тощо.

Але у більшості випадків, що зустрічаються на практиці, точне

значення ймовірності, або точний вираз функції розподілу, нам

невідомі. Тому постає питання про їх експериментальне визначення.

Математична статистика вивчає методи, які дають

змогу за результатами випробувань робити певні ймовірнісні

висновки.

Подамо деякі найпростіші задачі, що вивчаються в математичній

статистиці.

1 Нехай подія А має ймовірність, але її значення р=Р(А) нам

невідоме; необхідно оцінити „р” за допомогою випробувань.

2 Є цілий ряд важливих задач, пов’язаних з невідомими

функціями розподілу.

Так, може статися, що нам взагалі нічого не відомо про функцію

розподілу Р(х) випадкової величини X; тоді може бути поставлене

питання про наближене подання функції Е(х) за допомогою даних,

отриманих в результаті випробувань.

Проте, може бути і так, що нам відомо аналітичний вигляд

функції розподілу Е(х, а-і, а2, ... ,ак), але невідомі значення

параметрів а^ а2, ... ,ак, від яких залежить ця функція; треба знайти

оцінки цих параметрів.

Наприклад, якщо відомо, що випадкова величина розподілена

за нормальним законом, тоді її диференціальна функція розподілу

(щільність ймовірності) залежить лише від двох параметрів а, а І

саме їх потрібно оцінити за результатами випробувань.

3.2 Генеральна та вибіркова сукупності

Нехай потрібно вивчити сукупність однотипних об’єктів

відносно деякої якісної, або кількісної ознаки , які характеризують

ці об’єкти (наприклад, довжина).

На практиці, суцільне обстеження кожного з об’єктів сукупності

не провадиться, або тому, що сукупність об’єктів дуже велика, або

тому, що у деяких випадках обстеження пов’язане з руйнуванням

об’єктів.

43

На практиці випадково відбирають із цієї сукупності обмежене

число об’єктів і обстежують їх.

Означення 1. Вибірковою сукупністю (вибіркою) називають

сукупність випадково відібраних об’єктів.

Означення 2. Генеральною сукупністю називають

сукупність об’єктів, із якої добувається вибірка.

Оскільки умови експерименту вважаємо незмінними, а

результати експериментів - незалежними один від іншого, то

результати „п" експериментів х1( х2, .хп є незалежними у

сукупності випадковими величинами, що мають ту саму функцію

розподілу Е(х)/

Зауваження. На практиці вибір з генеральної сукупності

здійснюється так, що після кожного експерименту досліджуваний

елемент не повертається до генеральної сукупності перед

наступним відбором (так, наприклад, здійснюють вибірковий

контроль якості продукції). При цьому не можна вважати, що всі

експерименти проводяться в однакових умовах і їх результати

незалежні один від іншого, оскільки після кожного експерименту

склад генеральної сукупності змінюється.

Такий вибір називають вибором без повернення на відміну

від простого випадкового вибору, або вибору з поверненням .

Якщо генеральна сукупність достатньо велика, а вибірка по

своєму об’єму становить лише незначну Ті частину, то відміна між

цими двома типами вибору незначна, і нею можна нехтувати.

3.3 Статистичний розподіл вибірки

Нехай з генеральної сукупності ми добули вибірку, причому

значення „х/ спостерігалося „п/ разів, “х2” - п2 разів, ... , “хк” - пк

к

разів і =п - об’єм вибірки.

Спостережені значення "ж” називають варіантами, а

послідовність варіант, записана у зростаючому порядку, -

варіаційним рядом.

Числа спостережень „п” називають частотами, а їх

відношення до об’єму вибірки — = - відносними частотами,

п

Означення. Статистичним розподілом вибірки називають

перелік варіант і відповідних частот (або відносних частот).

П ри кл ад. ________

хі 2 6 12

Пі 3 10 7

44

або

Хі 2 6 12

3/20 10/20 7/20

Тут л-20, 4=^, У>, =1.

п

3.4 Емпірична функція розподілу

Нехай відомий статистичний розподіл частот кількісної ознаки

X. Введемо позначення: пх - число спостережень, при яких

спостерігалося значення ознаки Х<х; п - загальне число

спостережень (об’єм вибірки).

Відносна частота події Х<х дорівнює пх/п.

Якщо змінюється „х", тоді змінюється і відносна частота, тобто

відношення пх/п є функцією аргументу “х".

Означення. Емпіричною функцією розподілу (функцією

розподілу вибірки) називають функцію Е*(х), яка визначає для

кожного значення “х” відносну частоту події Х<х

Е(х) = Пх/п .

На відзнаку від Е*(х), функцію розподілу генеральної сукупності

(ГС) Е(х) = Р(Х<х) називають теоретичною функцією розподілу..

Зауважимо, що при великих об’ємах вибірки (п»1) Е*(х)

наближається до Е(х).

Властивості Е*(х):

1) значення Е‘(х) належать відрізку [0,1];

2) Е*(х) - монотонно зростаюча функція;

3) якщо X! - найменша варіанта, тоді Е(х) = 0 при хі х^

якщо хк - найбільша варіанта, тоді Е*(х) = 1 при х>хк.

Таким чином, емпірична функція розподілу може

застосовуватися для оцінки теоретичної функції розподілу ГС.

Приклад. Задано вибірку об’єму п =60. Визначити емпіричну

функцію розподілу Е*(х) і накреслити її графік:

45

1)х<2, Е*(х)=О; 2) 2<х< 6 , Ґ(х) = гн/п =12/60 = 0,2;

3) 6<х< 10ч Е’(х) = (т+ПгУл = 30/60 = 0,5;

4) х>10, Е*(х) = (п1+п2+п3)/п = 60/60 = 1.

Е їх)

0 2

3.5 Полігон І гістограма

Для наочності будують різні графіки статистичного розподілу,

зокрема, полігон і гістограму.

Означення. Полігоном частот називають ламану, відрізки

якої з’єднують точки з координатами (Хі.п^, (х2,П2), ..., (хк,пк)

Полігоном відносних частот називають ламану, відрізки

якої з’єднують точки з координатами (х^Д (х2,уу2), .... (хк,уук).

Приклад. Побудуємо полігон частот для вибірки об'єму п=100:

1.5

3,5 5,5

7,5

УУІ 0,1 0,2 0,4 0,3

Пі

100

1,5 3,5 5,5 7,5

46

У випадку неперервної ознаки доцільно будувати

гістограму, для чого інтервал, в якому знаходяться усі

спостережені значення ознаки (якщо вигідно, то інтервал можна

збільшити), ділять на декілька часткових інтервалів довжиною „Ь" і

обчислюють для кожного часткового інтервалу суму частот варіант

- Пі , які потрапили в і-ий інтервал.

Гістограмою частот називають ступінчасту фігуру, яка

будується із прямокутників, основою яких є часткові інтервали

довжиною „її”, а висоти дорівнюють відношенням п/Іі (щільність

частоти).

Площа і-го часткового прямокутника дорівнює Ітп/Іі = Пі - сумі

частот і-го інтервалу; таким чином, площа гістограми частот

дорівнює сумі всіх частот, тобто дорівнює об’єму вибірки.

Гістограмою відносних частот називають ступінчасту

фігуру, яка будується із прямокутників, основою яких є часткові

інтервали довжиною „Н”, а висоти дорівнюють \л/ Н (щільність

відносної частоти).

Площа і-го прямокутника дорівнює ітууі / ґі =>л/і - відносній

частоті варіант, які містяться у і-му інтервалі.

Таким чином, площа гістограми відносних частот дорівнює

сумі усіх відносних частот, тобто дорівнює одиниці.

Приклад. Побудувати гістограму відносних частот вибірки

об’єму п=100, припускаючи, що всі варіанти розташовані в інтервалі

(0, 10), і Ь=2.

Хі 1 3 5 7 9

Пі 10 15 40 23 12

0,1 0,15 |М 0,23 0,12

47

г 3.6 Статистичні оцінки параметрів розподілу

3.6.1 Статистичні оцінки параметрів розподілу

Нехай потрібно вивчити кількісну ознаку X генеральної

сукупності (ГС). Припустимо, що з теоретичних міркувань

встановлено який саме розподіл має ця ознака X.

Тоді потрібно оцінити параметри, які визначають цей розподіл.

Наприклад, якщо відомо, що ознака X, яка вивчається, в ГС

розподілена за нормальним законом, тоді необхідно оцінити ( знайти

наближено) математичне сподівання а і середнє квадратичне

відхилення а; якщо ж можна вважати, що ознака X розподілена за

законом Пуассона, тоді необхідно оцінити лише один параметр я .

Як правило, у роспорядженні дослідника є лише елементи

вибірки, наприклад, значення кількісної ознаки Хі, х2.хп, отримані

в результаті спостережень (тут і далі спостереження вважаються

незалежними).

Через елементи вибірки і треба виразити параметр, який

оцінюється.

Крім того, ми маємо право розглядати будь-яке число вибірок

об’єму „п” і тоді природно хь х2, ... , хп розглядати як незалежні

випадкові величини Хь Х2, ... , Хп.

Більш того, можна сказати, що „ знайти статистичну оцінку

невідомого параметра теоретичного розподілу” - це означає „

знайти функцію від випадкових величин, які спостерігаються, яка і

визначає наближене значення параметра, який оцінюється”:

Є-=/(Х„Х2,--,Х,).

3.6.2 Незсунені, конзистентні оцінки

Нехай © - деякий параметр теоретичного розподілу (

наприклад, математичне сподівання, дисперсія, медіана тощо).

Оцінкою цього параметра називають таку функцію

о* - /(х},х2,...,х„) від значень, що спостерігалися, яка у певному

розумінні мало відрізняється ВІД 0 .

У математичній статистиці розглядають оцінки, які

задовольняють певним умовам.

Означення 1. Оцінка 0’ = /(%,, лг2> ...,Л’„) параметра 0

називається конзистентною оцінкою цього параметра, якщо при

п -► +<ю ©• = /(х},х2,...,хп)-> о за ймовірністю

48

, = Ит /> . । \ .

(тобто РЦ0 -о >н=о).

п -> +00 1 1

Означення 2. Оцінку ©* = /(а'ра,і,...,аг„) називають

незсуненою оцінкою параметра о, якщо при будь-якому

натуральному„п” м(о’)-о.

Умова незсуненості означає, що похибка від заміни ©на ©’ не

має систематичного характеру.

3.6.3 Генеральна середня

Нехай вивчається дискретна генеральна сукупність відносно

кількісної ознаки X.

Генеральною середньою називають середнє

арифметичне значень ознаки X генеральної сукупності

її І.1

Очевидно, що

Р(Х = х,)=^,

N

тому

77 = м(х).

3.6.3 Вибіркова середня

Нехай для вивчення ГС відносно кількісної ознаки X відібрана

вибірка об’єму „п”.

Вибірковою середньою х^ називають середнє арифметичне

значень ознаки X вибіркової сукупності

_। *

-(*!«! +х2п2 ±... + хкпк\

П ,=Х

або

49

Зауваження. У теоретичних міркуваннях вибіркові значення

х1( х2, ... ,Хп ознаки X , отримані в результаті незалежних

спостережень, розглядають як випадкові величини Хь Х2, ... , Хп, які

мають однаковий з ознакою X розподіл і такі самі числові

характеристики.

3.6.5 Оцінка генеральної середньої через вибіркову середню.

Стійкість вибіркових середніх

Нехай з ГС добута вибірка об’єму „п”

Хі х1 х2 х3 ... хк

Пі Пі П2 Пз ... пк

Нехай генеральна середня хГ невідома і потрібно оцінити її за

даними вибірки.

В якості оцінки (наближеного значення) генеральної

середньої приймають вибіркову середню

Доведемо, що хЙ - незсунена оцінка алг. .

Маючи на увазі попереднє зауваження, розглянемо середню

вибіркову як випадкову величину, хь х2, ... , хк як незалежні випадкові

величини Х1} Х2, ... , Хк з однаковими розподілами, а тоді і з

однаковими математичними сподіваннями

М(Х)=а; М(Х1)=М(Х2)=.. =М(Хк)=а.

Але тоді

/_х /1 *

мЬг„)=м -У у

\ л /

= - Е М(Х, = - ^ап, = а = М(Л),

П п.

« П 7Г

тобто

м(у?)=х,-.

Крім того, можна довести, що вибіркова середня буде

консистентною оцінкою генеральної середньої

Хв -> за ймовірністю при умові, ЩО п -> -Н» .

50

З цього випливає, якщо з деякої генеральної сукупності добуті

декілька вибірок достатньо великого об’єму, то вибіркові середні

будуть наближено рівні між собою.

В цьому полягає властивість стійкості вибіркових

середніх.

3.6.6 Генеральна дисперсія

Для характеристики величини розсіювання значень кількісної

ознаки X генеральної сукупності навколо свого середнього значення

розглядаємо генеральну дисперсію.

Якщо значення ознаки X: х1( х2, ... , хк мають відповідно частоти

*

М1т N2...І\Ік, причому = .¥, то генеральна дисперсія дорівнює

ї=і

І=1

Генеральним середнім квадратичним відхиленням

(стандартом) називають квадратний корінь із дисперсії

= •

3.6.7 Вибіркова дисперсія

Для характеристики величини розсіювання значень кількісної

ознаки X вибіркової сукупності навколо свого середнього значення

^7, розглядаємо - вибіркову дисперсію.

Вибірковою дисперсією Ов називають середнє

арифметичне квадратів відхилень спостережених значень

ознаки X від їх середнього значення

3.6.8 Формула для обчислення дисперсії

Теорема. Дисперсія дорівнює середньому квадратів значень

ознаки X мінус квадрат середньої.

Доведення:

51

тобто

р^-ЕЬ (*)

3.6.9 Оцінка генеральної дисперсії

Нехай із генеральної сукупності витягнута вибірка з

і

поверненням об’єму к = :

1-і

Хь х2...Хк

Пі, п2, ..., Пк.

Потрібно за даними вибірки оцінити (наближено знайти)

невідому генеральну дисперсію.

Припустимо спочатку, що в якості такої оцінки ми візьмемо

вибіркову дисперсію ОВ.

Але виявляється, що вибіркова дисперсія Ов не є незсуненою

оцінкою для теоретичної, тобто генеральної, дисперсії Ог.

Перевіримо, що це саме так.

Введемо позначення: у, =хга N (де через “а"

позначено генеральну середню Л', = а).

Тоді

М(уі)=М(Х| - а)=М(Хі) - а =а - а=0.

(Тут ми врахували зауваження, а саме М(Х1)=М(Х2)=...=М(Хк)=а ).

Далі обчислюємо

М(Уі2)=М[(хі-а)2]=О(Хі)=Ог= а1,

□(уі)=0(хга)=0(хі)-0(а)=0(х|)=0г= а1.

За формулою (*)

- —2М^ )+М^у )= — п сгі 2 -М^у (3.1)

Оскільки у, і незалежні при і # і, то

м(у, -_уу) = м(у,)-М(уу)=0,

тому

м^]=мр1+^+-+^ї

\ п ./

Повертаючись до попереднього виразу (3.1), дістаємо

2 1

м(£й)=сг2 - —= —о-2 .

п п

(3.2)

Отже, м(/зя)^гг2, тобто Ов не є незсуненою оцінкою для

генеральної дисперсії.

За формулою (3.2) можна дістати незсунену оцінку для

генеральної дисперсії. Справді, розглянемо „виправлену" дисперсію

(3.3)

/7-1

Очевидно,

м(№)=мґ-і-Ов'] = -^-М(О,)=-^-—<т! =<г!

} п-\ п-1 п

і тому 82 є незсуненою оцінкою для генеральної (теоретичної)

дисперсії а2.

При л->-ню обидві величини Ов і 82 прямують до одної

границі і тому ця оцінка є також консистентною.

Для оцінки середнього квадратичного відхилення

використовують „виправлене" середнє квадратичне відхилення

Підкреслимо, що 8 не є незсуненою оцінкою і тому ми будемо

говорити так: „виправлене” середнє квадратичне відхилення.

Зауваження. На практиці виправленою дисперсією

користуються лише, якщо п<30.

3.7 Точкові оцінки, надійна ймовірність (надійність),

надійний інтервал

Означення 1. Точковою називають оцінку, яка визначається

одним числом.

Для вибірки малого об’єму точкова оцінка може значно

відрізнятися від параметра, який оцінюється, тобто приводити до

грубих помилок. Тому, при невеликому об’ємі вибірки треба

користуватися інтервальними оцінками.

Означення 2. Інтервальною називають оцінку, яка

визначається двома числами - кінцями інтервалу.

Якщо є*, яка знайдена за елементами вибірки, є оцінкою

(наближеним значенням) для невідомого параметра е (який

вважається величиною сталою), тоді 0* тим краще визначає 0,

чим меншим буде |0*-©|, тобто, якщо г>>() /|0-0’|<г> , то чим

менше £ , тим точніше буде оцінка 0‘.

Таким чином, <у>о характеризує точність оцінки.

Але статистичні методи не дозволяють категорично

стверджувати, що оцінка 0* задовольняє нерівності |©-0*|<£;

можна лише говорити про ймовірність /, з якою виконується ця

нерівність.

Означення 3. Надійністю ( надійною ймовірністю) оцінки

©* для 0 називають ймовірність /, з якою виконується нерівність

|©-©’|<<у :

/>(|0-0’| <<?)=/ . (3.4)

Як правило, надійність задається наперед, причому в якості у

визначають число близьке до 1, наприклад, 0,95; 0,99; 0,999.

Рівність (3.4) можна переписати так:

р(©’-г?<0<©’+^)=г . (3.5)

Останнє співвідношення треба розуміти так:

Ймовірність того, що випадковий Інтервал (©’ -<5 ,©’ + г>)

містить у собі ( накриває) невідомий параметр ©, дорівнює / .

54

Надійним називають інтервал (о* -в ,0* +г>) , який накриває

невідомий параметр с~) із заданою надійністю (Нейман-Фішер).

Зауваження. о* - випадкова величина і тому інтервал

(о*-£,0’+г>) має випадкові межі.

Тому, що випадковою величиною є не параметр (стала), який

оцінюється, а надійний інтервал, то правильніше говорити не про

ймовірність попадання о в надійний інтервал, а про ймовірність

того, що надійний Інтервал накриває о.

Як приклад, розглянемо надійний інтервал для оцінки

математичного сподівання нормального розподілу, якщо середнє

квадратичне відхилення а = є відомою величиною.

Нехай кількісна ознака X генеральної сукупності розподілена за

нормальним законом, причому середнє квадратичне відхилення а

цього розподілу відоме.

При цій умові треба оцінити невідоме математичне сподівання

„а” за допомогою вибіркової середньої х^.

Сформулюємо задачу так: знайти надійний інтервал, який

накриває „а” з надійністю / .

Будемо розглядати вибіркову середню хИ як випадкову

величину 77> а вибіркові значення х,,лг,•••,*„ - як однаково

розподілені випадкові величини Хь Х2, ... , Хп з однаковими

математичними сподіваннями і дисперсіями

М(Х,) = а, 7О(Л,)=<т.

Припустимо, без доведення, що, якщо X має нормальний

розподіл, тоді і л7> знайдена за допомогою незалежних

випробувань, теж розподілена нормально, причому має такі

параметри:

?- " =-£ми,) = -(™) = а,

\----------я./ і=і

,/+ = ) = _1_ па1 = _

V « ) п 7м п п

1 п л/п

55

Нехай тепер виконується співвідношення

(3.6)

де у - задана надійність.

Використаємо формулу

(Дійсно,

<?)=2ф[-|.

І СГ /

а + б - а

. ( а - 3 - а

-Ф -------

М’ї

- Ф — -Ф -- ,

а

1 - -

але функція Лапласа ф(л)=-— р 2 Ж - непарна ф(-*) = -ф(х) , і тому

72тг і

(3.7)

в якій замінемо X на хд , & - , тобто

7л

або

(3.8)

Із рівностей (3.6) і (3.8) випливає, що

2Ф(г)=і,

звідки, при відомій надійності у можна знайти Т, якщо використати

таблиці значень інтеграла Лапласа ф(х) :

56

Таким чином, можна записати таку робочу формулу

-і

Зміст отриманого співвідношення такий:

з надійністю у можна стверджувати, що надійний інтервал

(3.9)

накриває невідоме математичне сподівання „а”; точність оцінки

дорівнює

Зауваження 1. Із формули <? = -/= можна зробити такі висновки:

1) при зростанні об’єму вибірки „п" число спадає, отже

точність оцінки збільшується;

2) зростання надійності у = 2Ф(/) призводить до зростання „Ґ,

тому що ф(/) зростаюча функція, отже і до зростання б ;

Приклад. Випадкова величина X має нормальний розподіл з

відомим <т-3.

Знайти надійний інтервал для оцінки невідомого

математичного сподівання „а” за допомогою вибіркового середнього

Л7;, якщо об’єм вибірки п=36 і задана надійність оцінки у = 0,95.

Розв’язання: знайдемо „І”:

/ = 2Ф(/) ф(ґ)-| = 0,475.

57

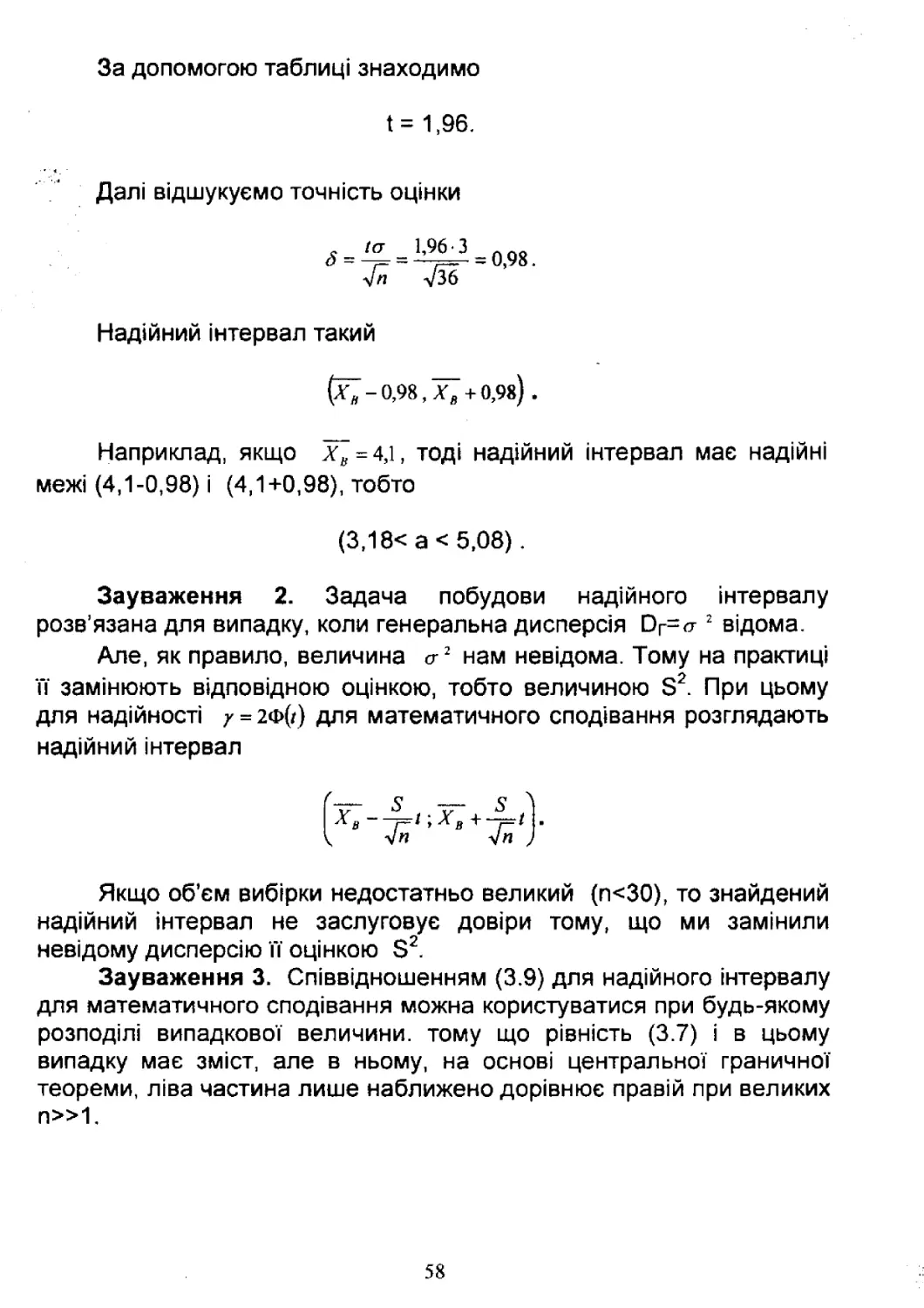

За допомогою таблиці знаходимо

1= 1,96.

Далі відшукуємо точність оцінки

<5 =

/ст

1,96 З

Тзб

= 0,98.

Надійний інтервал такий

(^7-0,98, Хв + 0,98) .

Наприклад, якщо хв = 4,1, тоді надійний інтервал має надійні

межі (4,1-0,98) і (4,1+0,98), тобто

(3,18< а < 5,08).

Зауваження 2. Задача побудови надійного інтервалу

розв’язана для випадку, коли генеральна дисперсія Ог=<т2 відома.

Але, як правило, величина о-2 нам невідома. Тому на практиці

її замінюють відповідною оцінкою, тобто величиною 82 При цьому

для надійності / = 2Ф(/) для математичного сподівання розглядають

надійний інтервал

^“77“ 8 "77“ 5 А

-Тд Г1 > В }•

< уП у/П )

Якщо об’єм вибірки недостатньо великий (п<30), то знайдений

надійний Інтервал не заслуговує довіри тому, що ми замінили

невідому дисперсію її оцінкою З2.

Зауваження 3. Співвідношенням (3.9) для надійного інтервалу

для математичного сподівання можна користуватися при будь-якому

розподілі випадкової величини, тому що рівність (3.7) і в цьому

випадку має зміст, але в ньому, на основі центральної граничної

теореми, ліва частина лише наближено дорівнює правій при великих

п»1.

58

3.8 Кореляційний зв’язок між випадковими величинами.

Регресія

3.8.1 Вивчення зв’язку за допомогою прямих регресії

В частині першій конспекту лекцій було введено поняття

коефіцієнта кореляції

між двома випадковими

величинами X і ¥.

При цьому було показано, що коли X і ¥ незалежні, то ^ = 0 ,

а коли X і ¥ зв’язані лінійною залежністю (і тільки в цьому випадку)

ІРлті = і •

Якщо о<Рхг <1, то X і ¥ залежні випадкові величини, і,

природно вважати, що, чим ближче |рхг| до 1, тим „ближче”

залежність між X і ¥ до функціональної залежності виду ¥=аХ+Ь.

Тому цілком природним є питання про наближене зображення

зв’язку між X і ¥ у вигляді лінійної функції ( для цієї мети

використовують також поліноми вищих степенів).

Означення. Пряма у=ах+р називається прямою регресії

(або прямою середньої квадратичної регресії) ¥ на X, якщо

коефіцієнти а, р обрано так, щоб середнє квадратичне відхилення

аХ + р від у було мінімальним

м[У ~(аХ + /?)]2 = тіп.

(3.10)

Аналогічно визначається пряма регресії X на ¥:

м[ал - (а! У + р 1 )]2 = тіп.

З умови (3.10) легко визначити а \ р . Виконавши

елементарні тотожні перетворення, дістанемо:

м[у - (« X + /У)]2 = м[{(У - М(у))- а(Х - М(х))}+ (м(у)~ а м(х)~ /?)]2 = м[ї - Л/(у)]2 -

- 2аЛ/[(Х - М(Х))- (У - Л/(У))] + а2 ЛГ[.Х' - Л/(А)]2 +

2М{(У - Л/(У))-а(X - Л/(^))]Л/(У) - аМ(Х) ~ /ї|}+ М[л/(У) - аМ(Х) - р]2 =

= м[у - М(У)]2 - 2а м[(А - Л/(Х)Ху - Л/(У))] + а 2м[х - М(Х)]2 + м[(Л/(У) -аМ(Х)-р)2^

59

= ау2-2аКХЇ +ага Х2+(М(У')-а М(Х)~ р)2 =

= |стгг- рхг2сгї,2|+ \р X?2 а / - 2а р Хі<т ха к + а2 ст х2}+ (А/ (К) - а М (X) - р)2 -

= а г 2(і - р 2)+ (р хг<т у-а а х )2 + (Л/(Г) - а М(Х) - р)2,

тобто маємо рівність

м[/-(«Л' +/7)]; =о-г2(1-рхг2)+(рЛ7сгг-аґ(Т^)2 +(Л/(У)-аЛ/(У)-/?)2, (3.11)

із якої випливає, що умову (3.10) буде виконано, якщо другий і третій

доданки правої частини дорівнюють нулю

(рхуїТу-аа х) = 0, (М(У)-аМ(Х)-р)=0,

ЗВІДКИ

а = Рхг.^, ^М(]'ра\рХ) . (3.12)

°х

Коефіцієнт а називається коефіцієнтом регресії У на X.

Рівняння прямої регресії ¥ на X має вигляд

Рху—х + (М(У)~а М(Х)),

<?х

або

а ( сг >

^-Л/(О = Рхг“2-^+ М(У)-рХТ-±М(Х) ,

V ах }

або

у-М(П = р„^Цх-ЩХ)). (3.13)

Аналогічно доводиться, що пряма регресії X на ¥ має рівняння

х-М(Х) = р„-±(у-М(ГІЇ. (3.14)

аг

Теорема. Пряма регресії ¥ на X збігається з прямою регресії

X на ¥ тоді і лише тоді, коли |д ^ | = 1.

60

Доведення. Порівнюючи рівняння (3.13) і (3.14), неважко

перевірити, що вони визначають одну пряму тоді і лише тоді, коли

=-------.тобто

* Л1 • ’ Л і

Р ХУ

Зауваження 1. З рівності (3.11) випливає, що для прямої

регресії У на X має місце співвідношення

МІ(Г-(аЛ- + /?))!]=(1-^„!)з-г2 (3.15)

(цю величину іноді називають залишковою дисперсією) ;

аналогічне співвідношення має місце і для прямої регресії X на У:

м[(л'На,к <3-16)

Звідси випливає, що чим менше відрізняється |р%г| від 1, тим

кращим можна вважати наближення У лінійним виразом а х + р .

Зауваження 2. Із рівнянь (3.13), (3.14) випливає, що обидві

прямі регресії проходять через точку (м(А’), л/(У)), яку називають

центром спільного розподілу випадкових величин X і У,

3.8.2 Вибіркові характеристики зв ’язку

Нехай X і У - випадкові величини, зв’язок між якими треба

вивчити; в результаті „п” випробувань дістали "п” пар значень цих

величин (хьу^ , (х2,у2),..., (хп,уп). _________

Вибіркові середні і дисперсії позначимо ВІДПОВІДНО х ,у ,стх2,а?2.

За оцінку коефіцієнта кореляції /?„ = р можна взяти вибірковий

коефіцієнт кореляції “г” - коефіцієнт кореляції між розподілами

вибірок ХЬ Х2, ... , Хп і Уі, у2, ... ,уп ; При цьому КОЖНІЙ парі (Х| , Уі), як і

при побудові одномірної функції розподілу вибірки, ми приписуємо

ймовірність 1/п .

Згідно з означенням коефіцієнта кореляції

(У ау ’ О" у

61

Аналогічно визначаються рівняння вибіркових прямих регресії:

прямої регресії ¥ на X

х—х - г

(3.18)

і прямої регресії X на ¥

(3.19)

Можна довести, що вибірковий коефіцієнт кореляції „г”, а отже і

вибіркові коефіцієнти регресії г=,г= є консистентними оцінками

а X а у

відповідних теоретичних параметрів.

Тому, при достатньо великих „п” можна сподіватися, що

вибірковий коефіцієнт кореляції і вибіркові прямі регресії будуть

мало відрізнятися від теоретичних.

З’ясуємо геометричний зміст вибіркових прямих регресії. Якщо

у = ах + р - рівняння вибіркової прямої регресії ¥ на X, то, згідно з

означенням прямої регресії за 3.8.1, повинно бути

-£(У| -ал,-Д)=іпіп.

Інакше кажучи, пряма регресії - це пряма, яку наближено проведено

через точки (Хі , Уі) (і=1,2.п) за методом найменших квадратів.

Отже, рівняння прямих регресії доцільно знаходити лише у

тому випадку, коли точки (хі(уі) (і=1,2,...,п) групуються поблизу

деякої прямої (це можна перевірити, наприклад, побудувавши ці

точки в Декартові системі координат). Якщо для точок (х, ,уі) не

спостерігається розміщення поблизу від чогось прямолінійного, то

замість прямих регресії можна розглядати лінії вищих порядків. Так,

наприклад, можна розглядати параболічну регресію

.у = ах2 + рх + у ,

замінюючи умову (3.10) на умову

62

3.9 Статистична перевірка статистичних гіпотез

3.9.1 Статистична гіпотеза. Нульова і конкуруюча,

проста і складена гіпотези

Означення. Статистичною називають гіпотезу про вид

невідомого розподілу, або про параметри відомих розподілів.

Наприклад, статистичними є гіпотези:

1) генеральна сукупність розподілена за законом Пуассона;

2) дисперсії двох нормальних сукупностей рівні між собою.

Поряд з висунутою гіпотезою розглядають і гіпотезу, яка їй

суперечить. Якщо висунута гіпотеза відкидається, тоді має місце

гіпотеза, яка їй суперечить.

Першу гіпотезу називають нульовою (основною) Но, другу -

конкуруючою (альтернативною) Н-|.

Наприклад: Но: а=10 ; а# 10 .

Простою називають гіпотезу, яка містить у собі лише одне

припущення, складеною - два або декілька.

3.9.2 Помилки першого та другого роду

Висунута гіпотеза може бути правильною або неправильною

(хибною).

Оскільки перевірку здійснюють статистичними методами,

гіпотезу називають статистичною гіпотезою.

В результаті статистичної перевірки гіпотези в двох випадках

може бути прийнято невірне рішення, тобто можуть бути допущені

помилки двох родів.

Помилка першого роду полягає в тому, що буде відкинута

правильна гіпотеза.

Помилка другого роду полягає в тому, що буде прийнята

неправильна гіпотеза.

Зауваження 1. Правильне рішення може бути прийнято теж у

двох випадках: 1) приймається вірна гіпотеза; 2) відкидається

невірна гіпотеза.

Зауваження 2. Ймовірність здійснити помилку першого роду

позначають а і називають рівнем значущості.

Для а часто використовують значення 0,05 або 0,01.

Наприклад, якщо рівень значущості а =0,05, то це означає, що

лише у 5 випадках із 100 буде відкинута правильна гіпотеза.

63

3.9.3 Перевірка гіпотези про нормальний розподіл генеральної

сукупності за допомогою ексцесу і асиметрії

Введемо такі означення.

Нехай деяка випадкова величина задана своєю щільністю

ймовірності Цх).

1 Центральним моментом к-го порядку називають вираз

М, = |(х - Л/(Х))* , к = 1,2,3, •

Очевидно,при К=1

М, = |(х - М{Х))/{хуіх = р/(х)Л - Л/(А') - Л/(.ї) = 0

тобто центральний момент першого порядку завжди дорівнює нулю.

При к=2

М2 = |(х - М(Х)У /Мсіх = £>(Л).

2 Асиметрією випадкової величини X називають відношення

м3 _ м3

о-’ (м2)^

З Ексцесом випадкової величини X називають різницю

або

Зауваження. Якщо розподіл випадкової величини X

симетричний відносно прямої х=гпх (М(Х)=тх ), тобто ї(х) є парною

функцією відносно аргументу х-тх , тоді всі непарні центральні

моменти дорівнюють нулю ( як інтеграли в симетричних границях від

непарних функцій), тобто і асиметрія А для таких випадкових

величин дорівнює нулю.

64

Розглянемо тепер випадкову величину X розподілену за

нормальним законом

а = тх

і обчислимо для неї асиметрію і ексцес :

і

' сіх - 0

а СГ УІІЯ-СГ

и = 23

(ІУ~ 2І 2 СІХ

и-х

бА-’ = 2І. 2 СІХ

сій - Зг2сІ2

г3

У = -Г2~

сій - сіх

2і

У=~Г2

Отже, для

величини X

теоретичного нормального розподілу випадкової

А=0 і Е=0.

Розглянемо тепер деяку генеральну сукупність і будемо

вивчати її відносно кількісної ознаки X.

Відомо, що таке дослідження має своєю метою відшукання

закону розподілу ознаки X та його параметрів.

За елементами вибірки ми можемо визначити наближені

значення його параметрів

ХВ ’ <?В =

і побудувати гістограму відносних частот. Вид гістограми може нам

допомогти висловити припущення (гіпотезу) про закон розподілу X

Наприклад, ми можемо висунути гіпотезу про нормальний

розподіл ознаки X генеральної сукупності.

65

Найбільш короткий шлях перевірки такої гіпотези полягає в

обчисленні асиметрії А і ексцесу Е за допомогою експериментальних

даних

де центральний момент будь-якого к- го порядку (Мк) обчислюється

за формулою

М4 = ~ (л, - хв У л, , к = 2, 3, 4.

п і=1

Якщо виявиться, що Ав і Ев мають невеликі значення, тоді

можна вважати, що гіпотеза про нормальний розподіл ознаки X

генеральної сукупності узгоджується з результатами експерименту.

Великі значення асиметрії Ав і ексцесу Ев вказують на значне

відхилення емпіричного розподілу від нормального.

Зауваження. Для різних знаків асиметрії А мають місце такі

види графіків щільності ї(х):

Тобто асиметрія додатня, якщо „довга" частина кривої розподілу

розташована з правого боку від математичного сподівання;

асиметрія від’ємна, якщо „довга" частина кривої розподілу

розташована з лівого боку від математичного сподівання.

На практиці знак асиметрії визначають по розташуванню кривої

розподілу відносно моди (точки максимуму ї(х)).

Для оцінки „крутості", тобто більшого або меншого підйому

кривої розподілу в порівнянні з нормальною кривою, використовують

ексцес:

66

4 ВД

Е>0

Е=0

Е<0

М(х)

3.9.4 Статистичні критерії перевірки нульової гіпотези

Для перевірки нульової гіпотези використовують спеціально

підібрану випадкову величину, точний, або наближений, розподіл

якої виявляється відомим.

Цю величину називають статистичним критерієм.

Після вибору критерію, множину усіх його можливих значень

поділяють на дві множини, які не перетинаються :

Одна з них містить у собі значення критерію, при яких нульова

гіпотеза відхиляється - критична область , друга - містить у собі

значення критерію, при яких нульова гіпотеза приймається

область прийняття гіпотези.

Основний принцип перевірки статистичної гіпотези

можна сформулювати так: за експериментальними даними

обчислюють спостережене значення критерію.

Якщо спостережене значення критерію належить області

прийняття гіпотези - гіпотезу приймають;

якщо спостережене значення критерію належить критичній

області - гіпотезу відхиляють.

Критерій перевірки гіпотези про можливий закон

розподілу випадкової величини X називають критерієм згоди.

3.9.5 Критерій згоди Пірсона

Нехай за вибіркою об’єму „п” отримано статистичний розподіл

Х( Хі х2

Пі П! П2

67

Припустимо, що ознака X генеральної сукупності розподілена

нормально і, при цьому припущенні, обчислені теоретичні

частоти п,'.

При рівні значущості а треба перевірити нульову гіпотезу :

ознака X генеральної сукупності розподілена нормально.

В якості критерію перевірки нульової гіпотези візьмемо

випадкову величину

{*)

тґ /ч

Ця величина випадкова, тому що в різних випробуваннях вона

отримує різні значення, які наперед не можна передбачити.

Але ясно, що чим менше відрізняються емпіричні і теоретичні

частоти, тим меншою буде величина критерію (*), отже, він в певній

степені характеризує близькість емпіричного і теоретичного

розподілів.

Доведено, що при п -> -ко закон розподілу випадкової величини

(*), незалежно від того, якому закону розподілу підпорядкована

генеральна сукупність, прямує до закону розподілу 3 »к”

степенями волі.

Тому випадкова величина (*) позначена через /2, а сам

критерій називають критерієм згоди „х> квадрат”.

Число степенів волі знаходять за рівністю

к=г-М,

де г - число груп (часткових інтервалів) вибірки;

І - число параметрів припущеного розподілу, які оцінені за

даними вибірки.

Зокрема, якщо припущений розподіл - нормальний, тоді

оцінюють два параметри (математичне сподівання „а” і середнє

квадратичне відхилення сг), тому І=2 і число степенів волі

к=г-2-1=г-3.

Якщо, наприклад, припускають, що генеральна сукупність

розподілена за законом Пуассона, тоді оцінюють лише один

параметр я , тому

к=г-1-1=г-2.

68

Правило. Для того, щоб при даному рівні значущості

перевірити нульову гіпотезу Но : ознака X генеральної сукупності

розподілена за нормальним законом.

Треба спочатку обчислити теоретичні частоти, а потім

спостережене значення критерію

і в таблиці критичних точок розподілу за даним рівнем

значущості а і числом степенів волі к=г-3, знайти критичну точку

/*/(« Д)

Якщо

- немає підстав відхиляти нульову гіпотезу.

Якщо

- нульову гіпотезу відхиляють.

СПИСОК ЛІТЕРАТУРИ

1 Гмурман В.Е. Теория вероятностей и математическая

статистика. - М.: Вьісшая школа, 1977.

2 Гмурман В.Е. Сборник задач по теории вероятностей и

математической статистике. - М.: Вьісшая школа, 1990.

69

70

І.В.Ковалішина

ТЕОРІЯ ЙМОВІРНОСТЕЙ

Конспект лекцій

Частина 2

Важливіші закони розподілу випадкової величини.

Випадкові вектори.

Елементи математичної статистики

Бібліотека УкрДАЗТ

Відповідальний за випуск Ковалішина І.В.

Редактор Дмитроченко Л.І.

Підписано до друку 23.02.04 р.

Формат паперу 60x84 1/16. Папір писальний.

Умовн.-друк.арк. 4,25. Обл.-вид.арк. 4,5.

Замовлення Тираж 300 Ціна

Видавництво УкрДАЗТу, свідоцтво ДК № 112 від 06.07.2000 р.

Друкарня УкрДАЗТу,

61050, Харків - 50, пл. Фейєрбаха, 7