Автор: Богуславский И.А.

Теги: регулирование и управление машинами, процессами эвм теория управления

Год: 1983

Текст

И. А. БОГУСЛАВСКИЙ

ПРИ ЛАДНЫ АДАЧ

ФИЛ. *А И

УПРА;Л Н •

9

ТЕОРЕТИЧЕСКИЕ ОСНОВЫ

ТЕХНИЧЕСКОЙ КИБЕРНЕТИКИ

И.А.БОГУСЛАВСКИЙ

ПРИКЛАДНЫЕ

ЗАДАЧИ

ФИЛЬТРАЦИИ

И УПРАВЛЕНИЯ

щ

да

МОСКВА «НАУКА»

ГЛАВНАЯ РЕДАКЦИЯ

ФИЗИКО-МАТЕМАТИЧЕСКОЙ ЛИТЕРАТУРЫ

4 983

32.81

Б73

УДК 62-50

Прикладные задачи фильтрации и управления. Ко г у с л а в-

ский И. А.—М.: Наука, Главная редакция

физико-математической литературы, 1983.— 400 с.

Излагаются методы определения оценок фазовых координат

объекта управления в темпе реального времени (методы

рекуррентной фильтрации) и методы использования этих оценок для

достижения целей управления (методы стохастического

управления). Алгоритмы решения задач фильтрации и стохастического

управления движением рассматриваются при дискретных

моментах измерения и управления, что важно при наличии ЭВМ в

системе управления. Применение алгоритмов иллюстрируется

примерами численного решения ряда модельных задач.

Книга предназначена для специалистов в области теории

управления, в частности — теории управления движущимися

объектами.

Табл. 11, илл. 15, библ. 63 назв.

Иосиф Аркадьевич Богуславский

ПРИКЛАДНЫЕ ЗАДАЧИ

ФИЛЬТРАЦИИ И УПРАВЛЕНИЯ

(Серия «Теоретические основы

технической кибернетики»)

Редактор Д. С. Фурманов

Техн. редактор Л. В. Лихачева

Корректор Е. В. Сидоркина

ИБ JS& 12413

Сдано в набор 27.09.82. Подписано к печати 02.06.83.

Т-12859. Формат 84х1087з2. Бумага тип. № 2.

Обыкновенная гарнитура. Высокая печать. Условн. печ. л. 21.

Уч.-изд. л. 22,55. Тираж 3250 экз. Заказ 352. Цена 3 р.60 к.

Издательство «Наука»

Главная редакция физико-математической литературы

117071, Москва, В-71, Ленинский проспект, 15

4-я типография изд-ва «Наука»

630077, Новосибирск, 77, Станиславского, 25

©Издательство «Наука».

*^«v,v,v,v,v,v, vw Главная редакция

Б ПЕ>о/по\ go 177-83 физико-математической

U5d(02)-oo литературы, 1983

ОГЛАВЛЕНИЕ

Предисловие 9

Введение ... 15

Глава 1. Рекуррентные уравнения оптимизации

дискретного стохастического управления . ... 19

§ 1.1. Постановка задачи синтеза оптимального

управления при неполной информации 19

§ 1.2. Модели объекта управления, возмущающих

шумов, ошибок измерений 22

§ 1.3. Влияние обратной связи на качество управления 28

§ 1.4. Основные леммы . 30

§ 1.5. Уравнения оптимизации при полной информации

о фазовых координатах 33

§ 1.6. Уравнения оптимизации при неполной

информации о фазовых координатах. Принцип

разделения 35

§ 1.7. Оптимальная оценка фазовых координат и

дуальное управление 40

§ 1.8. Уравнения оптимизации при ограничениях на

энергетику ' 42

§ 1.9. Уравнения оптимизации при ограничениях на

энергетику и число участков управления . . 46

§ 1.10. Уравнения оптимизации при* случайном моменте

остановки процесса измерений ..... 48

§ 1.11. Уравнения оптимизации при отсутствии

ограничений на последнее управление 51

§ 1.12. Задача оптимального управления при случайном

терминальном моменте 52

§ 1.13. Задача оптимизации при случайном и

управляемом терминальном моменте 55

1*

4

ОГЛАВЛЕНИЕ

Глава 2. Численные методы оптимизации

стохастического управления при полной информации ... 58

§ 2.1. Общая схема численной оптимизации ... 58

§ 2.2. Многомерная линейная интерполяция ... 59

§ 2.3. Определенные матрицы и выпуклые функции . 61

§ 2.4. Оценка накопления ошибок из-за линейной

интерполяции 63

§ 2.5. Некоторые свойства функций условных рисков . 68

§ 2.6. Методы нелинейного и стохастического

программирования 70

§ 2.7. Оптимизация с вычислением стохастических

квазиградиентов 81

§ 2.8. Оптимизация терминального управления с

вычислением стохастических градиентов 86

§ 2.9. Постановка задачи оптимизации методами

нелинейного программирования 91

§ 2.10. Многомерное нормальное распределение ... 92

§ 2.11. Уравнения эволюции статистических

характеристик в нормальном приближении 93

§ 2.12. Общий численный метод определения

статистических характеристик 98

§ 2.13. Алгоритм извлечения квадратного корня и

исправление к. м 105

§ 2.14. Алгоритм оптимизации управления .... 109

§ 2.15. Параметрическая оптимизация нелинейных

систем автоматического управления . . 111

Глава 3. Оптимизация стохастического управления

линейной системой ИЗ

§ 3.1. Объект управления 113

§ 3.2. Прогнозируемые фазовые координаты . . . 116

§ 3.3. Симметризация области допустимых векторов

управления 118

§ 3.4. Оптимизация методом стохастического

программирования ... 119

§ 3.5. Оптимизация методом нелинейного

программирования 121

§ 3.6. Функции условных рисков при терминальном

управлении 122

§ 3.7. Структура оптимального терминального

управления 130

§ 3.8. Оптимальное скалярное стохастическое

управление ...... 134

ОГЛАВЛЕНИЕ

§ 3.9. Особенности численной оптимизации

терминального управления 135

§ 3.10. Области достижимости детерминированного

терминального управления . 136

§ 3.11. Оценка областей случайных перемещений . . 139

§ 3.12. Определение областей оптимизации Stfk 140

§ 3.13. Оптимизация одномерного управления ... 142

§ 3.14. Оптимизация терминального управления при

ограничении числа участков управления . . . 144

§ 3.15. Оптимизация терминального управления при

случайном моменте остановки измерений . . . 155

§ 3.16. Области «нечувствительности» терминального

управления при учете энергозатрат 157

§ 3.17. Оптимизация управления при квадратичных

функциях потерь и отсутствии ограничений . 163

Глава 4. Рекуррентная фильтрация фазовых координат

линейной системы . 167

§ 4.1. Основные предположения 167

§ 4.2. Параметры условного нормального распределения 168

§ 4.3. Стохастическая наблюдаемость 174

§ 4.4. Последовательный алгоритм 176

§ 4.5. Алгоритм лаквидации особенности к. м. . . . 178

§ 4.6. Условные распределения марковской

последовательности и оценки по произвольному

критерию 179

§ 4.7. Марковская последовательность достаточных

статистик 184

§ 4.8. Априорная и апостериорная точность оценки

алгоритмов ОРФ 185

§ 4.9. Стохастическая наблюдаемость при

последовательных измерениях 189

§ 4.10. Алгоритм ОРФ при измерениях модели 1

(алгоритм Калмана) 191

§ 4.11. Достаточные статистики при измерениях модели 1 199

§ 4.12. Условия неособенности условных к. м. . . . 199

§ 4.13. Стохастическая наблюдаемость при измерениях

модели 1 ...... 201

§ 4.14. Влияние частоты измерений модели 1 203

§ 4.15. Предельное условное распределение .... 205

§ 4.16. Сходимость алгоритма ОРФ — «оценивателя» при

измерениях модели 1 210

§ 4.17. Алгоритм ОРФ при измерениях модели 2 . . 216

6 огЛаёЛёййё

§ 4.18. О сходимости алгоритма ОРФ при измерениях

модели 2 220

§ 4.19. Формирующий фильтр 221

§ 4.20. Алгоритм ОРФ при зависимых ошибках

измерений 225

§ 4.21. Достаточные статистики при измерениях

модели 2 230

§ 4.22. Рекуррентная фильтрация при измерениях

смешанной модели 232

§ 4.23. Проверка программы алгоритма ОРФ . . . 233

Глава 5. Алгоритмы ОРФ в некоторых задачах инерци-

алыюй навигации .

§ 5.1. Особенности компонент вектора измерений . . 235

§ 5.2. Задача математического согласования систем

координат (математическая выставка) .... 237

§ 5.3. Задача математической выставки при смешанной

модели векторов измерений 244

§ 5.4. Согласование географической системы координат и

системы координат гироплатформы перед началом

движения 245

Глава 6. Рекуррентная фильтрация при ошибках

априорных данных и вычислений 249

§ 6.1. Априорная и апостериорная точность оценки при

ошибках статистических характеристик . . . 249

§ 6.2. Сходимость алгоритма НОРФ при измерениях

модели 1 255

§ 6.3. Анализ влияния вектора «ухода нулей» и

формирующего фильтра случайных возмущений . . 258

§ 6.4. Анализ влияния вектора «ухода нулей» методом

моделирования 261

§ 6.5. Анализ влияния формирующего фильтра

случайных ошибок измерений 262

§ 6.6. Анализ влияния ошибок модели динамической

системы 265

§ 6.7. Влияние ошибок вычисления фундаментальной

матрицы уравнений модели 268

§ 6.8. Оценка влияния ошибок вычислений на БЦВМ 268

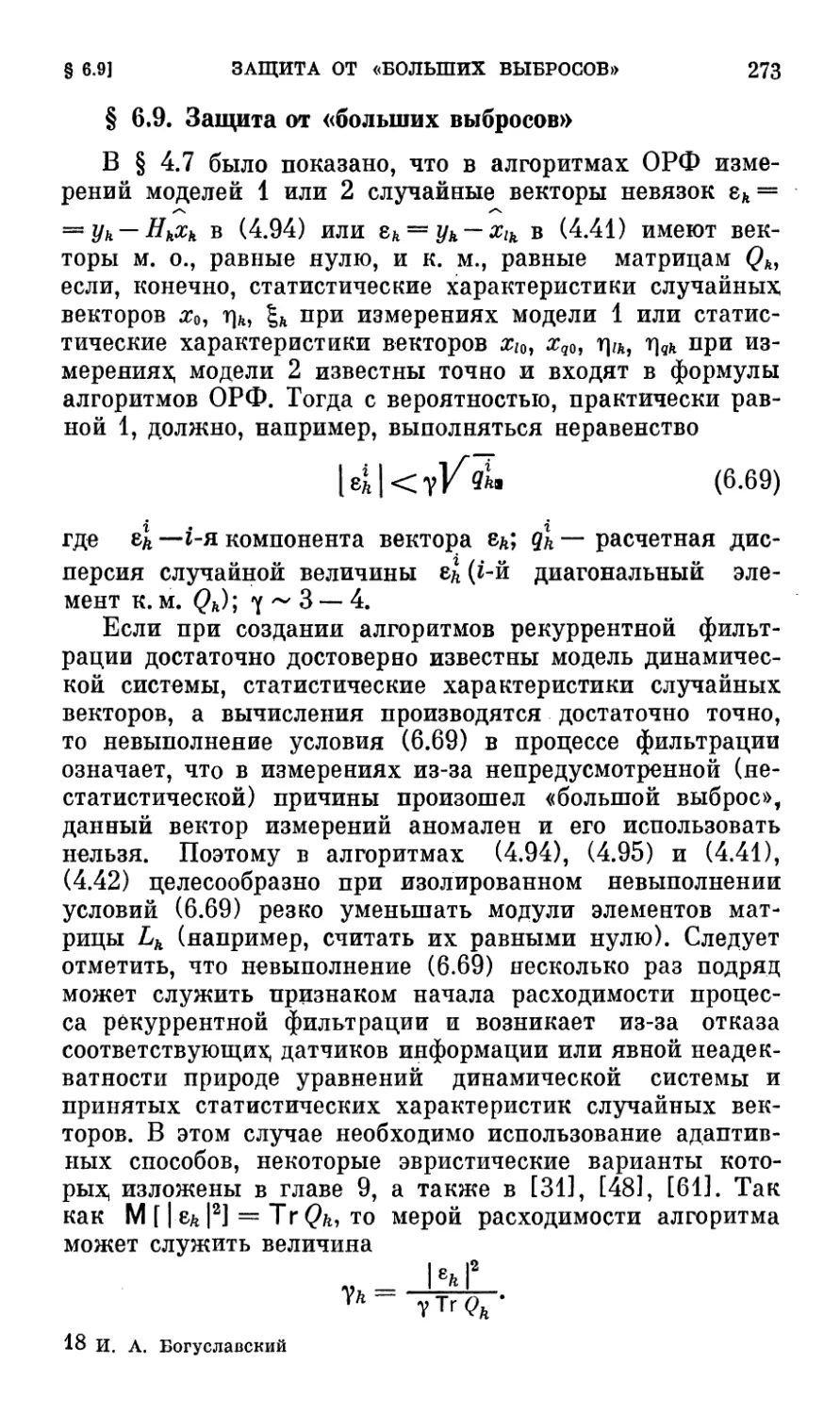

§ 6.9. Защита от «больших выбросов» 273

ОГЛАВЛЕНИЕ 7

Глава 7. Алгоритмы квазиоптимальной рекуррентной

фильтрации 274

§ 7.1. Основные предпосылки 274

§ 7.2. Уменьшение размерности путем перехода от

модели измерений 1 к модели измерений 2 275

§ 7.3. Уменьшение размерности путем преобразования

вектора измерений 280

§ 7.4. Алгоритм КОРФ, нечувствительный к «уходам

нулей» датчиков информации 283

§ 7.5. Двухчастотная рекуррентная фильтрация . . 286

§ 7.6. Суммирование — первичная обработка

поступающей информации 295

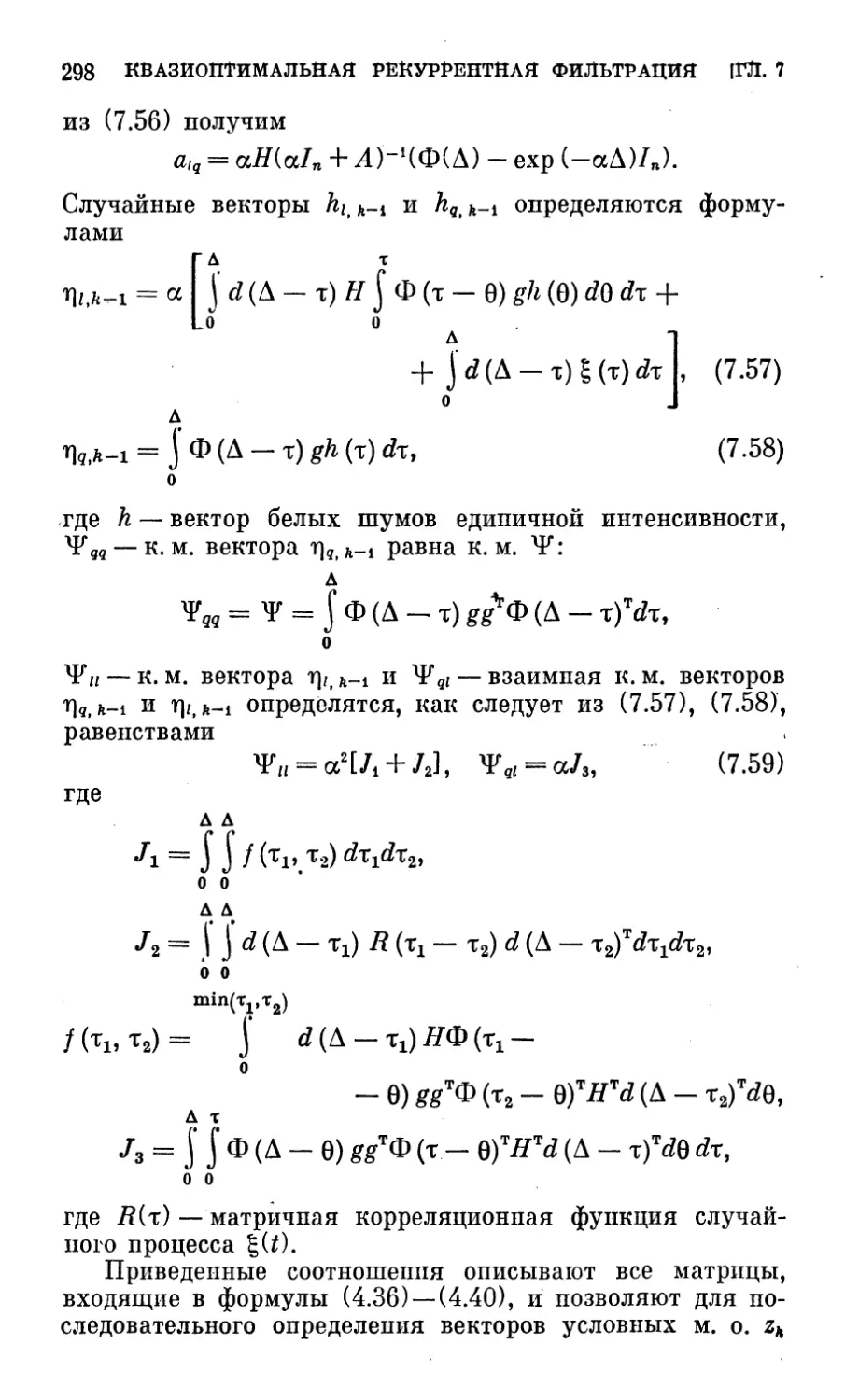

§ 7.7. Аналого-дискретная рекуррентная фильтрация . 296

§ 7.8. Две структуры алгоритмов КОРФ 300

§ 7.9. Модельная задача инерциально-допплеровской

навигации 303

Глава 8. Оптимизация стохастического управления

линейной системой при неполной информации . 308

§ 8.1. Уравнения и методы оптимизации .... 308

§ 8.2. Оптимизация при терминальном управлении . 312

§ 8.3. Аналитические решения задачи синтеза

стохастического управления 316

§ 8.4. Задача фактической выставки ЗСК . . . . 318

§ 8.5. Численный синтез оптимального управления при

и. = 2 (модельная задача мягкой посадки) . . 319

§ 8.6. Минимизация средних энергозатрат при неполней

информации 328

§ 8.7. Качество стохастического управления при

ошибках априорных статистических характеристик . 332

§ 8.8. Уравнения синтеза стохастического дуального

управления 335

Глава 9. Алгоритмы нелинейной фильтрации .... 338

§ 9.1. Задача нелинейной фильтрации 338

§ 9.2. Алгоритмы НЛРФ в нормальном приближении . 339

§ 9.3. Адаптивный алгоритм оценивания в нормальном

приближении 344

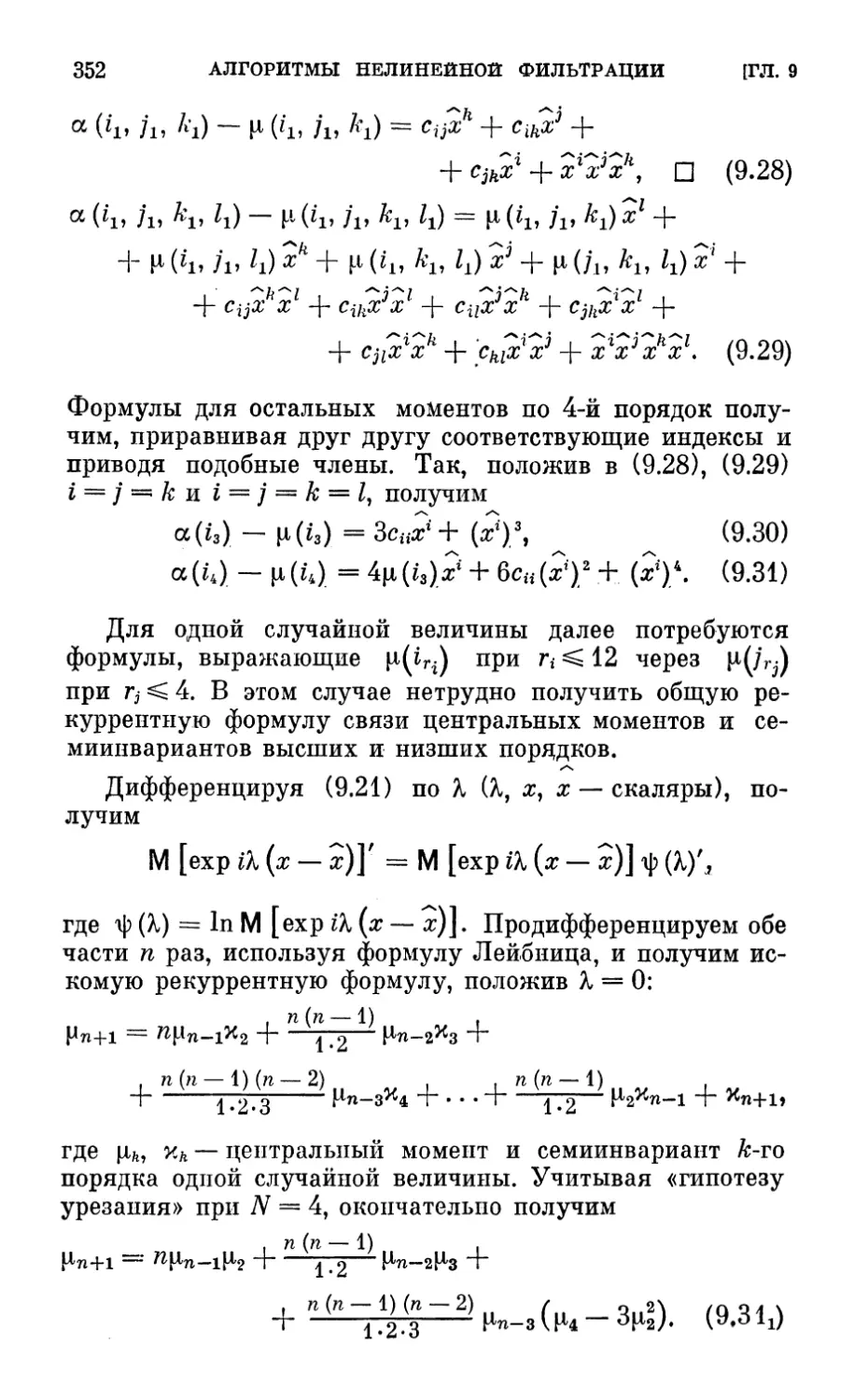

§ 9.4. Моменты и семиинварианты 349

§ 9.5. Параметры условного распределения в

ненормальном приближении ♦ . • . 353

8

ОГЛАВЛЕНИЕ

§ 9.6. Уравнения эволюции статистических

характеристик в ненормальном приближении .... 358

§ 9.7. Аппроксимация плотности вероятности вектора

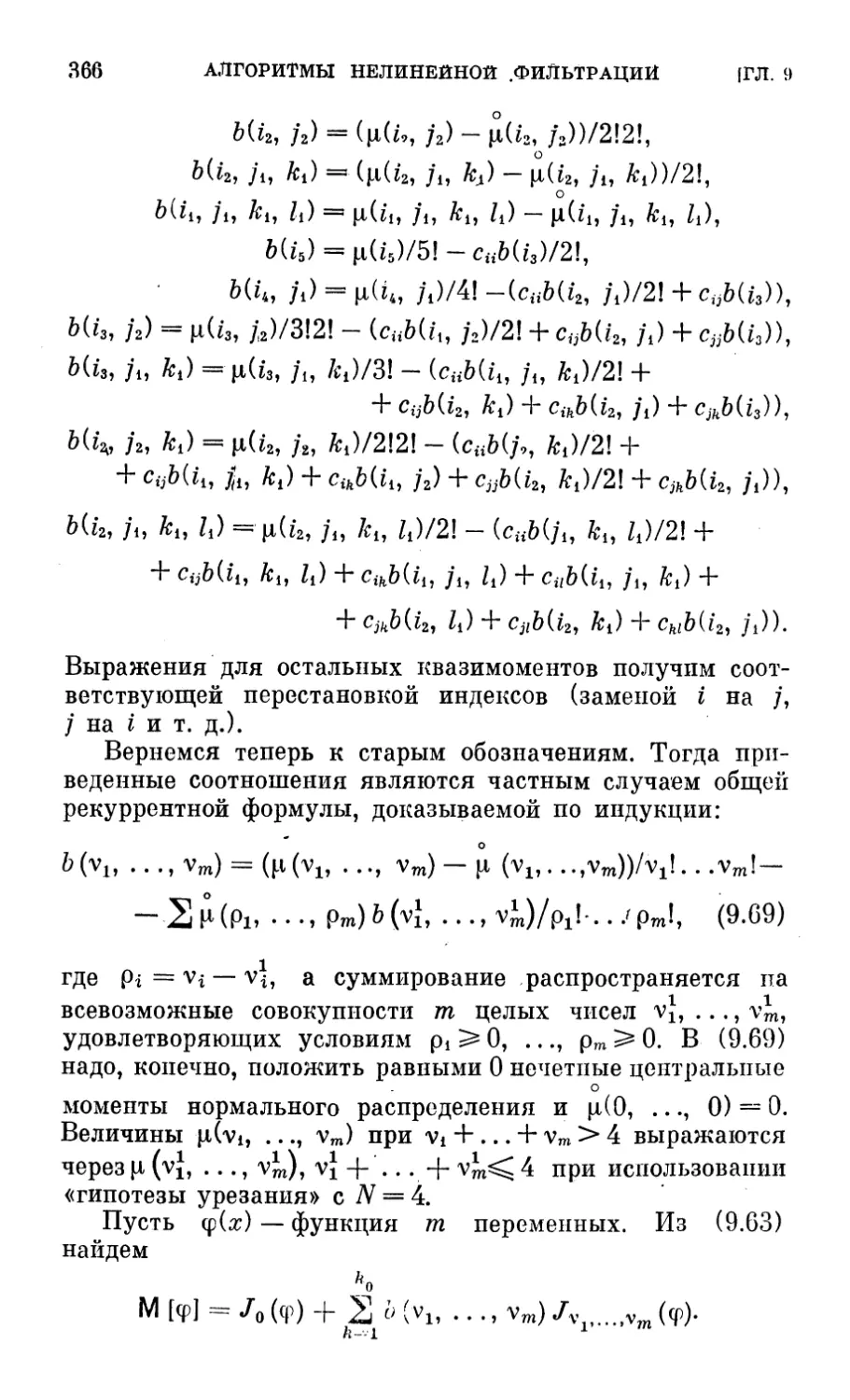

фазовых кординат 360

§ 9.8. Алгоритм НЛРФ в ненормальном приближении 368

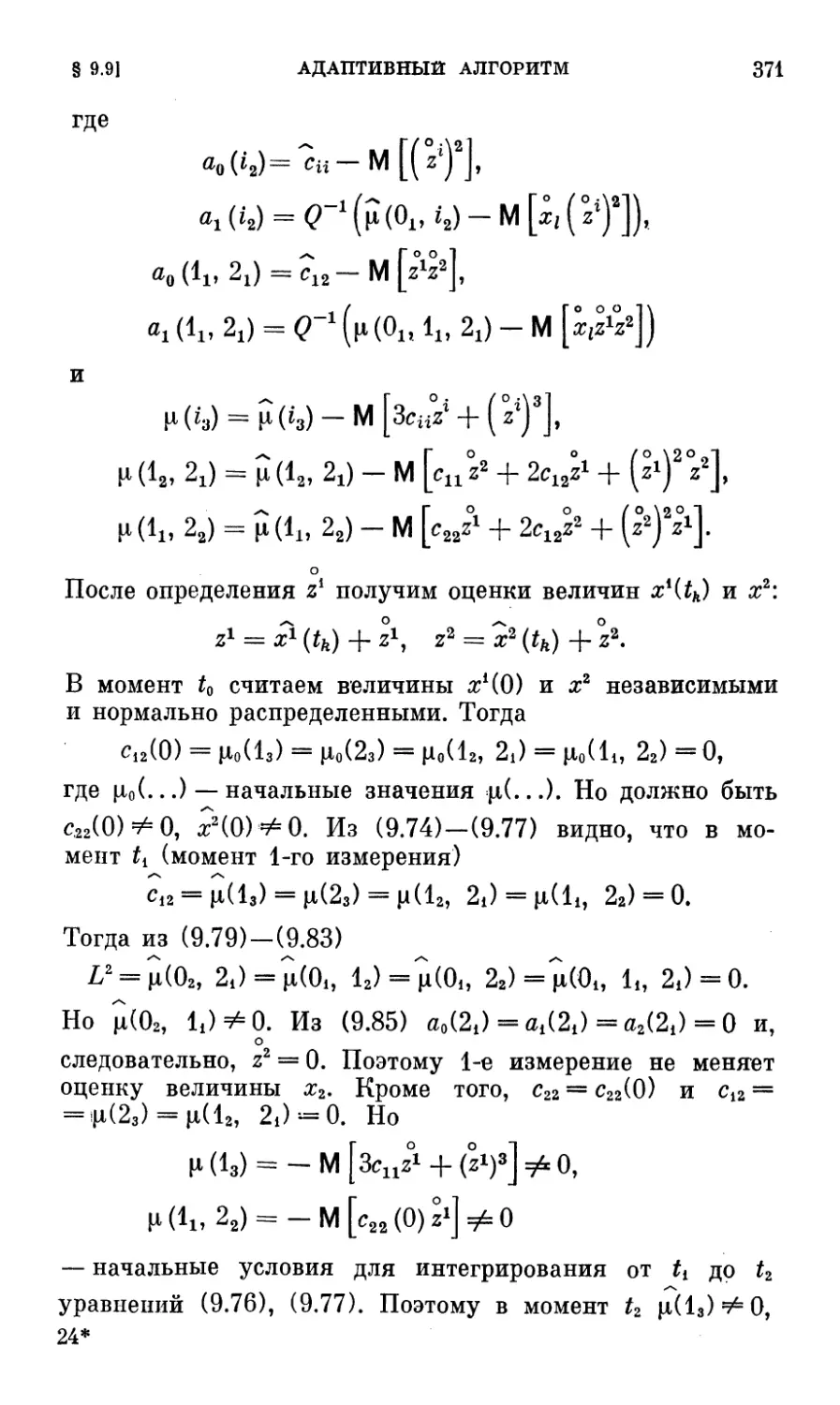

§ 9.9. Адаптивный алгоритм в ненормальном

приближении 369

§ 9.10. Алгоритм конечнозначной адаптации и

квазиоптимальное управление при многих гипотезах . 372

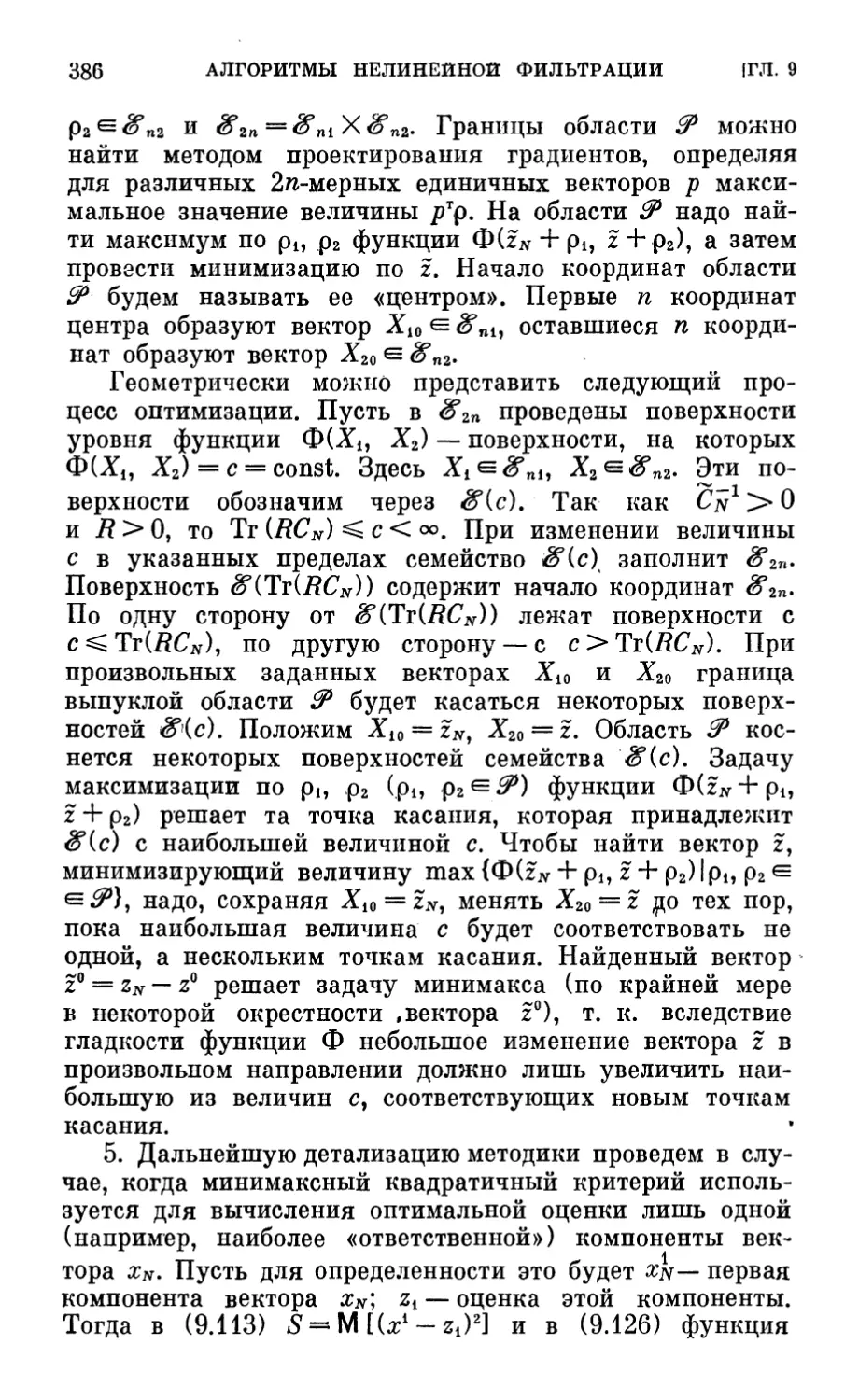

§ 9.11. Алгоритм минимаксной рекуррентной фильтрации 381

Литература ..«..«,.••• i i • *98

ПРЕДИСЛОВИЕ

В последние три десятилетия прикладная проблема

навигации и управления движением при наличии случай-

пых возмущений и ошибок измерений породила большое

число исследований, результатами которых оформились в

самостоятельное научное направление методы получения

оценок в темпе реального времени (методы рекуррентной

фильтрации) и методы использования этих оценок для

достижения целей управления (методы стохастического

управления). В данной книге, основанной на работах

автора последних лет [6] —[14], прикладные задачи

фильтрации и управления рассматриваются при дискретном

времени (дискретных моментах измерений) — ситуации,

имеющей наибольший практический интерес для систем

управления с ЦВМ (решения задач с непрерывным

временем в реальных системах управления неприменимы).

Главы 1—3, 8 посвящены задачам выбора дискретного

стохастического управления, а главы 4—7, 9 — задачам

выбора алгоритмов дискретной рекуррентной фильтрации.

В главе 1 для различных постановок задач синтеза

оптимального стохастического управления (при

ограничениях на векторы управлений, на энергозатраты, на число

участков управления, при случайных моментах окончания

измерений и управления) выводятся рекуррентные

уравнения для функций условных рисков (функций Беллмаиа)

в предположении существования марковской

последовательности достаточных статистик векторов фазовых

координат оптимизируемой стохастической системы в

моменты измерений. Это предположение позволило в общем

случае сформулировать принцип разделения, обычно

излагаемый лишь для линейных систем при квадратичном

критерии качества, рассмотреть задачу оценивания как

частный случай задачи управления, получить уравнения

дуального управления.

В главе 2 изучается задача численного решения

рекуррентных уравнений при использовании многомерной

10

ПРЕДИСЛОВИЕ

линейной интерполяции и проводится анализ накопления

ошибок. Рассматриваются алгоритмы оптимизации,

основанные на методах стохастического программирования

при вычислении стохастических квазиградиентов и

стохастических градиентов и на методах нелинейного

программирования при численном интегрировании уравнений

эволюции статистических характеристик в нормальном

приближении, сочетаемом с алгоритмом извлечения

квадратного корня из корреляционных матриц и их

исправлением. Для произвольных видов нелинейностей правые части

этих уравнений могут вычисляться с помощью

многомерного обобщения квадратурных формул наивысшей

алгебраической точности. Численный пример дает

представление о точности такого вычисления.

В главе 3 методы главы 2 применяются в задаче

оптимизации стохастического управления линейной (в

разомкнутом состоянии) стохастической системой при

условии, что ее координаты в дискретные моменты времени

измеряются без ошибок. Проводится качественное

исследование вида функций условных рисков и структур

оптимального терминального управления в скалярном и

векторном случаях, облегчающее применение численных

методов, описываются методика определения областей

оптимизации и особенности алгоритма численной

оптимизации терминального управления. Рассматриваются

два случая аналитического решения задачи синтеза: при

одномерном, симметрично ограниченном управлении и

четной функции потерь, не убывающей при

положительном аргументе, и при отсутствии ограничений на вектор

управления и квадратичной функции потерь. Для задач

оптимизации терминального управления при ограничении

числа участков управления, при случайном моменте

окончания измерений, при ограничении на энергетику

управления описывается методика определения областей

«нечувствительности» управления и даются рекомендации по

построению алгоритмов оптимизации. Приводятся

результаты численной оптимизации в функции числа измерений

стратегии одноимпульсыого управления в случае, когда

условный риск является вероятностью непопадания в

заданный отрезок.

В главе 4 выводятся различные варианты алгоритмов

рекуррентной фильтрации фазовых координат линейной

стохастической системы, выходом которых при

нормальном распределении первичных случайных факторов слу-

ПРЕДИСЛОВИЕ

U

жат условные математические ожидания этих

координат — векторы оценок, оптимальные по

среднеквадратичному критерию. Эти варианты соответствуют случаям

независимых ошибок измерений (модель 1), отсутствию

ошибок измерений (модель 2), ошибкам измерений,

получаемым на выходе некоторого формирующего фильтра

(модель 2), смешанной модели ошибок измерений.

Показывается, что эти алгоритмы являются той или иной формой

алгоритма Калмана и получаются в результате

применения леммы о параметрах условного нормального

распределения при определении достаточных статистик

марковской последовательности случайных векторов, у которых

часть компонент измеряется без ошибок. Выводится

последовательная форма алгоритмов, не требующая обращения

матриц. Рассматривается стохастическая наблюдаемость,

достаточным условием выполнения которой служат,

например, известные условия детерминированной

наблюдаемости Калмана. Для ряда случаев модели 1 исследуются

параметры предельных условных распределений,

получаемых при неограниченном увеличении числа измерений

или интервала между измерениями. Изучаются

параметры локального распределения — распределения ошибок

оценки при фиксированных произвольных начальных

условиях, характеризующие сходимость алг^ритма-оценива-

теля в среднем или среднеквадратичном; численный

пример дает представление об изменении в функции числа

измерений спектральной матричной нормы, позволяющей

судить о скорости убывания модуля вектора ошибок

оценки.

В главе 5 алгоритмы главы 4 используются для

решения возникающей в иыерциальной навигации задачи

оценки углов рассогласования и относительных уходов

зависимой и базовой систем координат в предположении, что

ошибки измерений на выходах интеграторов ускорений

образуют винеровский случайный 'процесс. Численный

пример дает представление об эволюции относительных

ошибок оценки при некотором периодическом законе

движения базовой системы координат.

В главе 6 точность оценки алгоритмами главы 4

исследуется при ошибках в априорных статистических

характеристиках первичных случайных факторов, ошибках

модели динамической системы, ошибках вычислений и

показывается несовпадение в этих ситуациях

характеристик априорной и апостериорной точности. Рассмотрение

12

ПРЕДИСЛОВИЕ

параметров локального распределения доказывает

устойчивость алгоритмов по отношению к ошибкам априорнда

статистических характеристик — сохранение свойств оце-

нивателя для широкого круга условий. Выводятся

рекуррентные уравнения, позволяющие последовательно

рассчитать параметры распределений векторов ошибок

оценки, возникающих из-за наличия непредусмотренных

математической моделью системы вектора «ухода нулей»

аппаратуры, формирующих фильтров ошибок измерений

и случайных возмущений. Описывается приближенная

методика определения ошибок условных корреляционных

матриц, возникающих при вычислениях на БЦВМ с

фиксированной запятой.

В главе 7 рассматриваются способы построения

квазиоптимальных алгоритмов рекуррентной фильтрации,

более удобные в реализации, чем оптимальные алгоритмы

главы 4. Излагаются способы уменьшения размерности

векторов и матриц, основанные на преобразовании

вектора измерений и переходе от модели измерений 1 к модели

измерений 2, выводятся рекуррентные уравнения для

расчета параметров распределений векторов ошибок оценки

квазиоптимальных алгоритмов. Приводится численный

пример изменения в функции числа измерений

спектральной матричной нормы, иллюстрирующей сходимость

квазиоптимального алгоритма-оценивателя, и численный

пример изменения относительных ошибок оценки при

использовании ква-зиоптимального алгоритма, нечувствительного

к «уходам нулей» аппаратуры датчиков информации.

Излагаются варианты квазиоптимальпых алгоритмов двух-

частотной и аналого-дискретной рекуррентной

фильтрации, уменьшающие требования к производительности

БЦВМ. Рассматриваются модельные примеры

использования квазиоптимальных алгоритмов при решении задач

инерциально-допплеровской навигации и орбитальной

навигации по данным от высотомера.

В главе 8 излагаются методы оптимизации

стохастического управления при неполной информации, основанные

на использовании алгоритмов главы 3, в которых роль

векторов фазовых координат в дискретные моменты

измерений играют векторы достаточных статистик,

поставляемые алгоритмами оптимальной рекуррентной фильтрации

главы 4. Проводится численный синтез (определяются

линии переключения и линии уровня функций условных

рисков) двумерного оптимального стохастического управ-

ПРЕДИСЛОВИЕ

13

ления мягкой посадкой, в которой условный риск

представляет собой вероятность непопадания в заданную

область высоты и вертикальной скорости в терминальный

момент. В функции числа измерений определяются

области «нечувствительности» оптимального импульсного

управления, у которого последний импульс ответствен за

точность, а предшествующие — за уменьшение среднего

значения энергозатрат. Излагается методика определения

качества управления, оптимального при среднеквадратичной

функции потерь, если алгоритмы оптимальной

рекуррентной фильтрации используются при ошибках априорных

статистических характеристик первичных случайных

факторов. —

Глава 9 посвящена алгоритмам нелинейной фильтрации,

решающим задачу приближенного определения векторов

условных математических ожиданий фазовых координат,

если при нормальных распределениях первичных

случайных факторов ненормальны условные распределения этих

координат. Излагаются алгоритмы нелинейной фильтрации

и адаптивные алгоритмы в нормальном приближении и

приводится численный пример использования адаптивного

алгоритма при неизвестной постоянной времени.

Алгоритмы нелинейной фильтрации в ненормальном приближении

строятся при использовании гипотезы «урезания»

(считаются равными нулю априорные и условные

семиинварианты порядка выше 4). Для дискретных моментов времени

решается задача определения параметров ненормального

условного распределения (вектора математического

ожидания и центральных момен'ЛЬ), если известны

результаты измерений и параметры априорных ненормальных

распределений. Последние определяются численным

интегрированием уравнений эволюции статистических

характеристик динамической системы между измерениями в

ненормальном приближении, являющимися обобщением

уравнений главы 2. При вычислении правых частей этих

уравнений используется аппроксимация плотности вероятности

фазовых координат отрезком ряда из многомерных

полиномов Эрмита, умноженного на плотность вероятности

некоторого многомерного нормального распределения.

Задача вычисления коэффициентов этого ряда (квазимоментов)

решается с помощью полученных иптегральпого

тождества и рекуррентного уравнения, которые сводят ее к

вычислению многомерных интегралов, нужных для численного

интегрирования уравнений нормального приближения

14

ПРЕДИСЛОВИЕ

главы 2. Излагается алгоритм конечнозначной адаптации,

в котором априорные данные о задаче адаптации сведены

к нескольким моделям линейных стохастических систем и

линейных измерений, одна из которых совпадает с

истинной моделью. Численный пример иллюстрирует уверенную

идентификацию в условиях, когда дисперсия ошибок

измерений неизвестна и заданы лишь ее возможные,

априори равновероятные значения. Излагается методика

решения задачи минимаксной фильтрации в статистически-

неопределенной ситуации, когда наряду со случайными

возмущениями и ошибками измерений существуют

неопределенные (нестатистические) возмущения и ошибки

измерений, для которых из априорных соображений

заданы лишь области существования.

Для овладения материалом книги читатель должен

хорошо знать основы математического анализа, теории

вероятностей и линейной алгебры в объеме курсов втуза.

Дополнительные сведения из математики, необходимые

для понимания материала, излагаются в соответствующих

местах книги.

Автор благодарит А. Е. Егорову за апробацию ряда

описанных алгоритмов и Г. Г. Богуславскую за большую

помощь при оформлении рукописи.

Список литературы ни в коей мере не является

библиографией по рассматриваемым в книге вопросам и

содержит лишь работы, упоминаемые в тексте.

Январь 1981 г.

И. Богуславский

ВВЕДЕНИЕ

При решении широкого круга прикладных задач

управления динамическими системами возникает проблема

оптимизации стохастического управления. Термином

«стохастическое управление» обычно называют закон или

алгоритм управления динамической системой, выбираемый

(синтезируемый) с учетом случайных факторов,

возмущающих движение динамической системы, и случайных

ошибок датчиков, которые снабжают контур управления

обратной связью — статистической информацией о текущих

фазовых координатах системы (рис. В.1). Поэтому в

системах стохастического управления с обратной связью в

Объект

управления

Датчики

информации

Шумы

Шумы

Контур

управления

БЦВМ

\

^

лсэ *>

55 £

И

«*>

Рис. В.1.

момент назначения управления учитываются как

априорные представления о законах распределения первичных

случайных факторов, так и поставляемые датчиками

сведения о текущем динамическом «портрете» системы —- ее

текущих фазовых координатах. Если эти сведения очень

16

ВВЕДЕНИЕ

грубы — информация о текущих фазовых координатах

поступает с большими ошибками или датчики информации

вообще отсутствуют, то система стохастического

управления с обратной связью становится системой

стохастического программного управления. В таких системах вектор

управления является функцией времени, которая

выбирается с учетом априорных представлений о распределениях

вектора начальных фазовых координат и случайных

возмущений так, чтобы был наибольшим некоторый средний

эффект управления.

Динамическая система и датчики информации могут

быть таковы, что измерение нужных для стохастического

управления с обратной связью фазовых координат

происходит с точностью, позволяющей не учитывать ошибки

измерений при синтезе алгоритма вектора управления.

В этом случае можно говорить о стохастическом

управлении по полной информации о фазовых координатах.

Однако в прикладных задачах (например, в задачах

управления движением различных объектов) часто

возникают ситуации, в которых нет возможности

непосредственно измерить нужные для управления фазовые координаты,

а величины, связанные с ними функциональной или

операторной связью, измеряются с заметными случайными

ошибками. В этом случае говорят о стохастическом

управлении по неполной информации о фазовых координатах.

Так, например, при управлении движением задача

стохастического управления по неполной информации

возникает из-за того, что для управления надо знать текущий

вектор скорости объекта, а для непосредственного измерения

доступны (причем с ошибками) лишь его текущие

линейные или угловые координаты.

При стохастическом управлении по неполной

информации общая задача управления содержит задачу оценки

фазовых координат по результатам измерений, которую часто

называют задачей фильтрации. Обычно оптимальное (или

по крайней мере практически целесообразное) управление

с сопутствующей ему фильтрацией требует использования

достаточно сложных алгоритмов для переработки

первичной информации, поступающей от датчиков, и вычисления

сигналов управления; эти алгоритмы, по-видимому, могут

быть реализованы лишь применением в замкнутой системе

управления бортовой цифровой вычислительной машины

(БЦВМ), которая в дискретные моменты времени

отбирает от датчиков первичную информацию, перерабатывает

ВВЕДЕНИЕ

17

ее и в дискретные моменты времени подает новые сигналы

управления на входы контура управления объектом.

При большом объеме информации и сложных

алгоритмах фильтрации и управления ограниченная

производительность современных БЦВМ препятствует решению

задач фильтрации и управления с большой частотой (т. е. с

малой дискретностью), позволяющей использовать

алгоритмы фильтрации и управления при непрерывном

времени (применение этих алгоритмов при решении различных

задач описано, например, в [2], [3], [10], [341, [50], [56]).

По этой причине не удается использовать известный

алгоритм Калмана [27], [46], решающий задачу оптимальной

фильтрации при непрерывном времени и записываемый

в виде стохастического дифференциального уравнения.

Наличие БЦВМ в системе управления и относительно

малая частота (т. е. большая дискретность) решения

упомянутых выше задач оправдывают специальное

рассмотрение задач с дискретным временем — задач дискретного

стохастического управления и дискретной фильтрации,

которым посвящена эта книга.

Основное внимание уделено численным методам

оптимизации алгоритмов управления и фильтрации при

использовании ЦВМ, а также примерам, иллюстрирующим

применение этих методов для решения некоторых

модельных задач навигации и управления движением. Автор

отчетливо понимает, что в инженерных задачах существует

достаточно плавная зависимость эффективности

управления от «степени оптимальности» методов управления и

фильтрации. Поэтому стремление использовать в

алгоритмах управления реальной системы результаты решения

задачи оптимизации представляется зачастую ничем не

оправданным. Однако инженер-исследователь должен быть

убежден, что эффективность выбранного к реализации

варианта алгоритма управления близка к эффективности

оптимального алгоритма управления, который поэтому

целесообразно пытаться синтезировать, несмотря на

«проклятие размерности» и «априорную опасность» — так обычно

называют основные трудности, ожидающие исследователя

па тернистом пути оптимизации стохастических систем.

Впрочем, «априорная опасность», возникающая из-за

отсутствия априорных данных о статистических

характеристиках случайных факторов в важных инженерных

задачах (например, задачах управления движением, задачах

навигации и обработки результатов наблюдений), часто

18

ВВЕДЕНИЕ

преувеличивается, так как исследователь на основании

накопленного опыта в проектировании и испытании

аналогичных систем достаточно уверенно оценивает

максимальные случайные ошибки, максимальные случайные

возмущения, максимальные разбросы начальных условий,

максимальные интервалы корреляции и, пользуясь в

соответствии с неравенством Чебышева правилом «2о» или

«За», без значительных погрешностей может назначать

первые два момента случайных величин и корреляционные

функции случайных процессов, входящих в описание

математической модели системы управления; известный

закон больших чисел обычно позволяет без значительной

идеализации считать первичные случайные величины

нормально распределенными. Эти соображения, конечно, не

исключают необходимости исследования

чувствительности эффективности стохастического управления и

фильтрации к вариациям априорных статистических

характеристик. Методики проведения такого исследования в книге

обсуждаются достаточно подробно.

Следует отметить также, что быстрый рост

производительности и объемов памяти БЦВМ, наблюдаемый в

последние годы, позволяет надеяться на постепенное

преодоление трудностей «проклятия размерности» и на

аппаратурное обеспечение реализации сложных и близких к

оптимальным алгоритмов управления и фильтрации.

В книге систематически используются прикладная

теория статистических решений и «байесовский подход»,

оценивающие эффективность управления и фильтрации

средними значениями некоторых величин, вычисляемых по

априорным распределениям первичных случайных

факторов. Информированность исследователя о характере

априорных распределений позволяет при байесовском подходе

синтезировать более естественные алгоритмы управления

и фильтрации, чем при максималистском минимаксном

подходе.

ГЛАВА 1

РЕКУРРЕНТНЫЕ УРАВНЕНИЯ ОПТИМИЗАЦИИ

ДИСКРЕТНОГО СТОХАСТИЧЕСКОГО УПРАВЛЕНИЯ

§ 1.1. Постановка задачи синтеза

оптимального управления при неполной информации

Существует большое число различных постановок

задач синтеза оптимального управления динамической

системой, возмущаемой случайным процессом шумов, в

условиях, когда измерения фазовых координат системы или

величин, от них зависящих, производятся или точно, или

со случайными ошибками. Рассмотрим достаточно общую

постановку задачи при фиксированном времени

управления и для нее получим рекуррентные уравнения,

определяющие оптимальное дискретное стохастическое

управление с обратной связью.

Управление производится на отрезке времени [t0, Т],

где t0, Т заданы. У динамической системы тг-мерный

вектор фазовых координат х удовлетворяет уравнению

x = f(x, и, h, t), (1.1)

где и — 7П-мерный вектор управления, h — v-мерный

вектор случайных шумов, возмущающих систему, / —

заданная вектор-функция соответствующего числа переменных.

В моменты времени t0, ..., tkj ..., tN (tN < T) измеряются

Z-мерные векторы обратной связи у0, ..., 1/А, ..., yN,

несущие информацию о векторе х. Векторы yk имеют вид

yk = mtk,xk, Ы, (1.2)

где xk = x(tk), |ft — Z-мерный дискретный случайный

процесс ошибок измерений, Н — заданная вектор-функция

соответствующего числа переменных. Называть yh векторами

обратной связи естественно, так как, далее, векторы

управлений зависят от ук и, следовательно, как видно из

(1.2), зависят от текущих xh. Поэтому векторы и влияют

на текущие xh, а последние — на векторы и.

В задаче стохастического управления при полной

информации компоненты векторов хк измеряются без

20 ОПТИМИЗАЦИЯ ДИСКРЕТНОГО УПРАВЛЕНИЯ [ГЛ. 1

ошибок и, следовательно,

yk = xh. (1.3)

Далее, вектор управления на интервале [tk, tk+i)

обозначается через ИьСт). Синтез в момент tk должен назначить

вектор управления uk(i), который в каждой конкретной

реализации процесса управления должен быть

неслучайной (нерандомизированной) функцией т и зификсирован-

ных векторов обратной связи 1/0, ..., j/ft, ... (обоснование

использования нерандомизированного управления

приведено, например, в [51]). Ожидаемое качество управления

на интервале Т характеризуют величиной среднего

риска S:

S = M [ |><(*ь Щ) + ®(*г)1 (1.4)

где хт = х{Т); ©*, ю — неотрицательные функции от хи хт

и неотрицательные функционалы от функций ик(т).

В (1.4) осреднение производится по всем возможным

случайным векторам х0, gfc (/с = 0, ..., Л0, случайным

процессам hit). Осреднение по случайным процессам можно

понимать, например, следующим образом. В [43]

показано, что достаточно общий случайный процесс может быть

представлен его каноническим разложением: линейной

комбинацией неслучайных функций времени с

коэффициентами, которые неслучайны в данной реализации

случайного процесса, но случайны на множестве реализаций.

Тогда осреднение по возможным случайным процессам

hit) означает осреднение по множеству этих случайных

коэффициентов. Функции, стоящие в квадратных скобках

правых частей равенства (1.4), обычно называют фу ищи-

ями потерь. Наиболее часто используются квадратичные

функции потерь:

юЫ =?xTRx, (dkix, и) = xTRkx + uTQku, (1.5)

где R, Rky Qk — матрицы соответствующей размерности.

Далее, верхним индексом «т» всегда обозначаются

транспонированные векторы-столбцы и матрицы.

В приводимых ниже примерах синтеза оптимального

управления часто используется следующий специальный

вид функции ш(#), облегчающий численную оптимизацию

и дающий четкое физическое представлепие о качестве

управления: со(лг) = 0, если для каждой компоненты х*

(£«*1, . ,м п) вектора х справедливо |я*|^й<; (&(х) *= 1 в

§ 1.1] СИНТЕЗ УПРАВЛЕНИЯ ПРИ НЕПОЛНОЙ ИНФОРМАЦИИ 21

противном случае. Область, в которой юЫ — О, будет п-

мерным прямоугольным параллелепипедом, симметричным

относительно начала координат. Очевидно, что в этом

случае величина среднего риска S = М [о (%т)] есть

вероятность непопадания вектора хт в этот прямоугольный

параллелепипед.

Функцию о)Ы в (1.4) обычно называют терминальной

функцией потерь. Если в (1.4)

©«(#, и) вэ 0, i = 0, ..., N,

то средний риск S называется терминальным. В этом

случае векторы управлений ответственны лишь за среднее

значение функции от вектора конечного состояния

динамической системы. Везде далее считаем, что качество

управления тем выше, чем меньше величина среднего риска

S. Поэтому задача оптимизации стохастического

управления заключается в выборе оптимальных управлений и0,...

..., ц*, минимизирующих величину среднего риска.

На множества допустимых векторов управлений uk

обычно наложены ограничения uk e °Uh, где % —

выпуклые области, содержащие вектор, равный нулю (напомним,

что область выпуска, если она содержит все точки

отрезка, концы которого ей принадлежат). Далее, яг-мерное

евклидово пространство будем обозначать через <Sm. Если

°Uh — &т, то ограничения отсутствуют.

Для применимости при оптимизации мощных

вычислительных методов нелинейного и стохастического

программирования, далее, на интервалах [£*, tk+i) считаем векторы

управления uk(r) постоянными: uk(r) = uh. Это условие не

является принципиальным ограничением, так как в

случае необходимости можно вектор uh(r) считать

постоянным на нескольких интервалах, составляющих интервал

[tk, tk+l), и путем расширения вектора управления

прийти к случаю uh(r) = uk = const. Поэтому S = S(u0, ..., uN).

Минимальную величину среднего риска и

соответствующие ей оптимальные управления будем обозначать верх-

пим индексом «О»: S0 ии^.

Задачу оптимизации сформулируем в следующем виде:

найти векторы Wq, ..., и% и число S0 из условия

S° = S (ut • • •, и%) = min {S (м0, ..., uN) | u0 <= <U^...

...,г/л<=ад. (1.6)

(Строго говоря, символ min в (1.6) надо было бы заменить

22 ОПТИМИЗАЦИЯ ДИСКРЕТНОГО УПРАВЛЕНИЯ [ГЛ. 1

на символ нижней грани inf, так как минимума функции

S(u0, ..., uN) в принципе может и не существовать. Однако

везде далее сохраняется символ min, так как вычисли-

оо

тельный алгоритм определения векторов щ, ..., un

практически использует конечное число шагов и обычно не

достигаются ни минимум (если он существует), ни нижняя

грань.)

К описанной постановке задачи с помощью

множителей Лагранжа сводится задача на условный экстремум

среднего риска. Так, например, пусть стохастическое

управление должно минимизировать терминальный средний

риск S — М [со (%т)] при условии М [г|) (хт)] = 0, где

г|)(#) — некоторая положительная функция. Образуем

средний риск Q = М [со (хт) + Ад|) (#т)], где % —

неопределенный множитель, и найдем зависящие от X оптимальные

управления, минимизирующие Q. После этого величину Я

надо определить из условия М[г|)(яг)] = 0.

§ 1.2. Модели объекта управления,

возмущающих шумов, ошибок измерений

Разработка математической модели (уравнений

движения) объекта управления, а также математических

моделей случайных процессов возмущений hit) и ошибок

измерений |ft, «удобных» при исследованиях на ЦВМ и в то

же время «похожих» на реальный объект управления и

реальные случайные возмущения и ошибки измерений,—

сложная экспериментальная и теоретическая задача,

решение которой в каждой прикладной ситуации

предшествует оптимизации управления.

Несмотря на упомянутые во введении правила «2о»

или «За», построение моделей для hit) и £ftB ряде случаев

осложняется тем, что их устойчивая статистика может не

существовать из-за ее зависимости от неопределенных

(нестатистических) факторов. Иногда указанная

статистика более менее достоверно находится лишь при

проведении специальных экспериментальных исследований

серийно выпускаемых систем управления и датчиков

информации, что делает ее определение затруднительным. В то же

время обычно оптимизация управления должна быть

проведена на стадии проектирования при отсутствии

надежных экспериментальных данных о hit) и |fc. Поэтому

указанные модели выбираются из прагматических

соображений «удобства» работы на ЦВМ и интуитивных сообразщь

§ 1.2] МОДЕЛИ ОБЪЕКТА, ШУМОВ, ОШИБОК ИЗМЕРЕНИЙ 23

ыий соответствия реальным случайным величинам и

процессам в аналогичных системах, прошедших

экспериментальную отработку и испытания. Как известно, в состав

математического обеспечения современных ЦВМ входит

стандартная программа генерации случайных,

нормально распределенных, независимых чисел. Поэтому

приемлемые для исследований на ЦВМ математические модели

hit) и £ft являются некоторыми операторами (обычно их

называют формирующими фильтрами), которые из этих

чисел арифметическими действиями и операциями

присвоения образуют случайные процессы возмущений и ошибок

измерений.

Далее используется следующее определение

марковского векторного случайного процесса: zit) — марковский

векторный случайный процесс, если

pizit)/zixh), ..., zi%0)) = pizit)/zixh)),

где £>Tft> ...> т0; pizit)/...) —условные плотности

вероятностей вектора zit).

Для обеспечения возможности использования мощных

теоретических и численных методов анализа и синтеза

стохастических систем будем требовать, чтобы при

фиксированных векторах управлений uk (например, при uft =

= 0) была марковской случайная последовательность х01

хи ..., xkJ ... векторов фазовых координат объекта

управления, описываемого уравнением (1.1). В терминах теории

автоматического управления это означает, что в

разомкнутой динамической системе (вектор управления uk не

зависит от векторов обратной связи у0, ..., yN) векторы xh

образуют марковскую последовательность. В замкнутой

динамической системе (управления — функции векторов

обратной связи) марковости векторов xk обычно не

существует. Исключением служит случай дискретного

стохастического управления по полной информации.

Если случайные процессы Ш), возмущающие систему

на непересекающихся интервалах времени [£*, U+i) и

[tj, fj+i), статистически независимы, то последовательность

xh — марковская. Действительно, в этом случае, как

следует из дифференциального уравнения (1.1),

распределение вектора xk+i зависит только от xk (вектор xh+l

полностью определен вектором начальных условий xk,

некоторым фиксированным вектором uk и случайным

процессом hit) при t^[tk, th+i)7 независимым с й(т) при %<tk).

24 ОПТИМИЗАЦИЯ ДИСКРЕТНОГО УПРАВЛЕНИЯ [ГЛ. 1

Примером случайного процесса hit), обладающего

указанным выше свойством, служит широко используемый в

прикладных исследованиях дискретный белый шум.

Последний строится следующим образом. Все интервалы

времени [£*, £*+1) делим на интервалы длиной б, на каждом из

которых случайный вектор hit) постоянеп, его компоненты

нормально распределены и статистически независимы,

имеют равные нулю математические ожидания и

дисперсии, равные б"1. При б -*• 0 hit) переходит в некоторую

математическую абстракцию, называемую белым шумом.

Дискретный белый шум является допредельной моделью

белого шума. Из допредельной модели следует, что если

hit) — белый шум, то М [hl(t)hl(i)] = б(£ — т), где

Л'Ш — i-я компонента hit); б(t) — дельта-функция. Так

как преобразование Фурье от б-функции равно (2л)~1/2,

то компоненты белого шума имеют единичную

спектральную плотность. Далее всегда дискретный белый шум,

постоянный на интервалах времени длиной б, обозначаем

через /г6Ш, а белый шум, получаемый при б ->■ 0,

обозначим через hit): hit) = h0it).

Если анализ и синтез стохастического управления

производятся только о помощью прямых численных методов:

анализ •— методом Монте-Карло, синтез — методом

стохастического программирования (см. главу 2), то модель

объекта управления можно описывать широким классом

уравнений вида

я = /(:г, ц, hit), t) (1.7)

при условии выполнения требования: для достаточно

малых величин б статистические характеристики векторов хк

(например, первые два момента) практически не должны

зависеть от б. Но для исследований на ЦВМ

математическая модель в виде (1.7) задана лишь, если задан метод

численного интегрирования уравнения (1.7).

Принципиально выполнение требования: на интервале длиной б

постоянства вектора h6it) численное интегрирование

уравнения (1.7) производится каким-либо численным методом

(например, методом Эйлера с шагом, существенно

меньшим, чем величина б, или методом Рунге — Кутта с

автоматически выбираемой в функции заданной точности

длиной шага), в процессе применения которого учитывается

переменность вектора #, удовлетворяющего (1.7) при

постоянном векторе h6(t). Поэтому даже при сколь угодно

малой величине б недопустимо, например, применение в

§ 1.21 МОДЕЛИ ОБЪЕКТА, ШУМОВ, ОШИБОК ИЗМЕРЕНИЙ 25

общем случае метода Эйлера с шагом, равным б, который

вектор x((i+l)8) определит формулой

*((*+1)6)-*(Й)+ /(*(«), щ ЬьШ, Ш, (1.8)

где кьШ) равен случайному вектору h^t), постояппому

при t e [jS, (i+ 1)8). Использование этого метода со сколь

угодно малым шагом 8 применительно к уравнению вида

(1.7) вызывает, вообще говоря, появление принципиальных

ошибок в статистических характеристиках вектора х. Так,

пусть в (1.7)

fix, и, h&it), t)=*Ax + g(x)hb(t).

Тогда из (1.8) " "

хШ + 1)8) = (1 + А6)хШ + g(x(ib))h6Ub)6. (1.9)

Осредняя обе части (1.9), получим, что величины mi =

= М [х (гб)] определяются рекуррентным уравнением

mi+l = (l + A8)mh (1.9')

так как М \g (х (18)) h& (£8)1 = 0 (случайные величины

g(x(iS)) и Мй) независимы, и М [йб (*8)] = 0). Однако

в действительности ^%***Ш* 4

f x(Q)dQ \+M\h(tS) f g(*(e))d9

(1.10)

Так как функция #Ш непрерывна, то второе слагаемое в

правой части (1.10) при малой величине б приближенно

можно считать равным Ат$. Однако третье слагаемое в

(1.10) всегда не равно нулю, так как #(0) зависит от Mift)

при 6^ [£8, (£+1)8]. Поэтому, если методом Монте-Карло

определять т,, интегрируя много раз уравнение х — Ах +

+ g(x)h6 методом Эйлера с шагом б и осредняя затем

результаты интегрирований, то получим неверные значения

т{\ правильные величины т{ найдём, если числа #((£+1)8)

будем определять, например, интегрированиями этого

уравнения от t = i8 до t = (i + 1)8 методом Рунге — Кутта

при начальном условии x(i8) с шагом, автоматически

выбираемым из условия достижения заданной точности, или

методом Эйлера с шагом, существенно меньшим величины

б. Правда, как следует из материала § 2.12, для уравнения

вида

x = f(x, и, t) + g(zt и, t)hM) (1.11)

26 ОПТИМИЗАЦИЯ ДИСКРЕТНОГО УПРАВЛЕНИЯ [ГЛ. i

метод Эйлера с малым шагом б дает в принципе

правильные результаты, если этим методом численно

интегрировать не первоначальное уравнение (1.11), а

вспомогательное уравнение

x = f*(x, и, t) + g(x, щ t)h(t), (1.110

где вектор-функция /*(#, и, t) определена в § 2.12.

Вышеизложенное проиллюстрируем на примере

уравнения

£ = — ах + bxh6(t). (1.12)

Из материала § 2.12 следует, что при S -> 0 величина

т (t) = М [х (t)] удовлетворяет уравнению

^ = (-a + -i-ba)j

и, следовательно,

m(t) = m (0) ехр {(- а + \ bA *}. (1.13)

Определение величины т(1) методом Монте-Карло при

числе опытов N = 1000 и численном интегрировании

уравнения (1.12) внутри интервалов длиной б методом Рунге —

Кутта показало при а = 1/2, 6 = 1, что в соответствии с

формулой (1.13) равенство 7?г(1) = т(0) выполняется с

ошибкой, не большей 5% при б < 0,01. Если (1.12)

интегрировать методом Эйлера с шагом б, то методом Монте-

Карло получим, что m(l) ~ т(0) ехр (— 1/2) и,

следовательно, значительна ошибка определения т(1).

Итак, модель объекта управления включает уравнение

вида (1.7) и метод его численного интегрирования. Из-за

необходимости использования сложного метода

численного интегрирования на каждом интервале длиной б время

расчета на ЦВМ каждой реализации процесса управления

может быть немалым, что потребует больших затрат

времени работы ЦВМ для анализа и синтеза управления

методами Монте-Карло и стохастического программирования.

Запись модели объекта управления в виде уравнения

(1.11) позволяет приближенный анализ системы

управления проводить не методом Монте-Карло, а более

экономно — путем численного, а иногда и аналитического

интегрирования уравнений, которым приближенно

удовлетворяют законы изменения статистических характеристик

вектора x(t); правда, оценка степени приближения, вооб-

§ 1.21 МОДЕЛИ ОБЪЕКТА, ШУМОВ, ОШИБОК ИЗМЕРЕНИЙ 27

ще говоря, неизвестна и может быть достоверно найдена

лишь сравнением с результатами применения метода

Монте-Карло. Вместо стохастического программирования

синтез законов управления проводится более экономными

методами нелинейного программирования.

Следует отметить, что так как в правую часть

уравнения (1.7) входит быстро меняющийся вектор /гбШ,

дисперсии компонент которого равны б"1, то при малой величине

6 велика дисперсия по крайней мере некоторых компонент

вектора x(t) и траектория движения точки x{t) в фазовом

пространстве содержит быстрые изломы. По этой же

причине некоторые компоненты вектора x{t) в (1.11) при

замене ht(t) на hit) имеют бесконечно большую дисперсию.

Поэтому модели вида (1.7) или (1.11) дают довольно

грубую идеализацию «природы», у которой фазовые

траектории обычно достаточно гладки. Эта идеализация — плата

за обеспечение марковского свойства у последовательности

векторов хк.

Рассмотренные выше случайные возмущения следует

считать «быстрыми» возмущениями динамической

системы. Кроме них, на систему часто действуют «медленные»

случайные возмущения, имеющие физический смысл

«уходов нулей» усилителей мощности исполнительных

элементов контура управления, «уходов нулей» датчиков

информации, угловых скоростей «дрейфа» гироплатформ инер-

циалыюй навигации и т. д. Обычно компоненты векторов

этих «медленных» возмущений считают полиномами от t

с неизвестными, но постоянными в данной реализации

управления случайными коэффициентами. Дополняя этими

коэффициентами вектор фазовых координат системы,

получим «расширенную» динамическую систему, на которую

действуют только «быстрые» случайные возмущения.

Для дискретного случайного процесса ошибок

измерений £fc широко используются модели двух видов.

Модель 1: в (1.2) ^ — последовательность случайных

независимых векторов.

Модель 2: 1* = £(£*), где £U) — процесс, задаваемый

формирующим фильтром вида

6 = F(S, Г, *>, (1-14).

где |' — вектор белых шумов.

Образовав из компонент векторов х и | вектор фазовых

координат новой динамической системы, а из векторов h и

£' — вектор нового возмущающего белого шума, получим,

28 ОПТИМИЗАЦИЯ ДИСКРЕТНОГО УПРАВЛЕНИЯ [ГЛ. 1

что модель 2 соответствует случаю, когда динамическая

система описывается уравнением вида (1.1), в котором

случайные возмущения являются белым шумом, а

компонентами векторов обратной связи служат измеряемые без

ошибок функции от компонент вектора фазовых

координат;

yk = Hk(tk, xh). (1.15)

§ 1.3* Влияние обратной связи

на качество управления

Покажем, что измерение векторов обратной связи

i/o, ..., Ун позволяет уменьшить величину среднего риска

S при оптимальном синтезе векторов управлений. Пусть

вначале полезные измерения отсутствуют. Подобная

ситуация возникает, например, если ошибки измерений

очень велики (измерения не несут информации о векторе

фазовых координат). Средний риск S запишем в виде

S = S (и01 ...л uN) = J R (xor .. .j xT, u0, .. .± uN) p (xor ...

.. #1 xTl uQl, ..., hjv) dx0.. .dxTl (1.16)

где p{...) — плотность вероятности векторов x0l ..., хт,

зависящая от векторов щг ..., uN как от параметров,

'N

R (х0, ..., xTl иог ..., uN) = 2 со (хи щ) + со (хт).

1=0

Интегрирование в (1.16) проводится по {N+ 1) X тг-мерно-

му пространству возможных последовательностей

векторов х0, ..., хт (в дальнейшем часто встречаются

многомерные интегралы типа (1.16), являющиеся формальной

записью величины математического ожидания; для

сокращения формул область интегрирования не

указывается, если она совпадает со всем евклидовым пространством

соответствующего числа измерений).

Оптимальные управления и|>> • • ч u°n найдутся при

решении задачи (1.6): минимизации правой части (1.16) при

ограничениях uk^°Uk. В результате минимизации

получим оптимальные программные управления и& = и0 (к)

Векторы ul зависят лишь от моментов управлений, могут

быть найдены до начала управления динамической

системой и занесены в память БЦВМ.

§ 1.3] ВЛИЯНИЕ ОБРАТНОЙ СВЯЗИ НА УПРАВЛЕНИЕ 29

Пусть теперь существуют случайные векторы t/0, ..., J/jv,

статистически связанные с векторами xQj ..., хт. Это

означает, что существует их совместное распределение, причем

р (#о> • • м *Г| и0, • • -2 un) = J P ixox • • -i хт/Уо, ...

• •., Уя)р{Уог • • ч yN)dy0.. .dyN, (1.17)

где /?(.../...) и /?(...) — зависящие от щ, ..., uN условная

(при фиксированных у0, ..., yN) плотность вероятности

векторов х0, ...у хт и плотность вероятности векторов

j/o» ..., Ум* Подставляя (1.17) в (1.16) и меняя порядок

интегрирования, получим

S(u0i . .м зд) = J J(y0> ..., yNxUQr ..., uN)dy0...dyN,

(1.18)

где положено

J (У or • • •, yNt uor ...,uN) = p (y0, ..., yN) J R (x0l ...

..., xT% uQ, ..., uN)p{x0, .../...., j/iv)^0 ••• ^r. (1.19)

Допустим, что в каждой реализации векторы j/0, •.., У к

фиксируются, так что и0, ..., и* можно строить

функциями компонент этих векторов. Для минимизации S(u0, ...

..., uN) надо минимизировать подынтегральную функцию

в (1.18); оптимальные управления

ul = ul{yQ,...xyN) (1.20)

получим при определении минимального среднего риска

S0:

S° = S(u°0l ..., и%) = Jmin{/(y0l ...,yNl u0, ...

..., uN) | uh e °Uk} dyQ... dyN.

Ho

min{j/(j/0? ...,i/iv, uQ1 ...tuN)dyQ.... dyN\uk^°U^^

> J min {/ (yQ, ..., у^, u0, ... i/jv) | wA e= %} dy0 ... dyN.

(1.21)

Поэтому средний риск при оптимальном программном

управлении (этот средний риск — величина в левой части

(1.21)) больше, чем средний риск при оптимальном

управлении (1.20), использующем информацию о векторах об-

30 ОПТИМИЗАЦИЯ ДИСКРЕТНОГО УПРАВЛЕНИЯ [ГЛ. i

ратной связи у0, ..., yN. В (1.21) неравенство переходит в

равенство, когда векторы х0, ..., хт и векторы г/0, ..., У и

статистически независимы. Действительно, в этом случае

в .(1.19)

р{х01 . . ., Хт/уо, . . ., yN) = />Uo, . . ., #г, Но, .. ., UN)

и (1.18) перейдет в (1.16), так как

Следует отметить, что в (1.20) вектор оптимального

управления в момент th является функцией как прошлых,

так и будущих векторов обратной связи и физически

нереализуем. Для обеспечения физической реализуемости

везде ниже требуем выполнения условия

Иа=Иа(Уо. ...,Уа)« (1.22)

Второй (интегральный) множитель в правой части

(1.19) можно назвать «средним риском в данной

реализации векторов» уо, ..., yN- Минимизация выбором

векторов управлений ид, ..., uN среднего риска в данной

реализации еще не гарантирует минимизации среднего риска

S(u0, ..., uN), так как от этих векторов зависит еще и

распределение векторов обратной связи у0, ..., yN,

описываемое в (1.19) функцией р(у0, ..., yN). В задачах

оптимизации оценки фазовых координат динамической

системы можно ограничиться минимизацией среднего риска

в заданной реализации, так как функция р(у0, ..., yN)

не зависит от результата оценки (если, конечно,

результаты оценки не используются при построении векторов

управлений).

§ 1.4. Основные леммы

Чтобы добиться замкнутости изложения и избежать

ссылки на стохастический принцип оптимальности Бел-

лмана, намеченный в [51 и названный автором

«интуитивным» [5, стр. 105, 108], вывод рекуррентных уравнений

оптимизации дискретного стохастического управления с

обратной связью будем основывать на двух простых леммах.

Лемма 1.1. Обозначим

J (г|>, z) = min { J г|> (х) f (х, z, и) dx + Ф (z, и) \ и е °U),

(1.23)

где if, /, ф — положительные функции, a z — некоторый

вектор. Тогда, если я^Ы < г|?2Ы, то Дг|?1, z)</(i|>2, z).

§ i.4] ОСНОВНЫЕ ЛЕММЫ 31

Действительно, пусть /(i|?i, z) и Дф2т z) достигаются

соответственно при и = u±(z) и и = u2(z). Тогда

справедливость леммы сразу следует из неравенства

J №v z) = J 1>i (x) f (*. z> u°i (z)) dx + <p (z, u\ (z)) <

< j ti (x) f (x> z, ul (z)) dx + ц (z, u%(z)) <

< J N>1 (X) + A (*)] / (*i 2, ^2 (2)) d* + ф (*, И? (Z)) =

= J(^>2, z),

где ДЫ = г|)2Ы — t|)i(#) > 0 по условию.

Лемма 1.2. Пусть Jr — функционал от функций щ —

=*и{(хи ..., £0) (ui^°Ui, J = 0, ..., г) определяется фор-

мулой

Jr = J 0 (агг+1) /г (arr+i, агг, кг) .. ./0 (а^, ar0, и0) / (ж0) rfa:r+i...

... dx0 -f" J сог (#r, wr) /r_i (#г, д?г-1, wr_i) ... /о (#i, #o> wo) X

X / (x0) dxr ...dx0+ ... + \(o1 (xv ux) /0 (xv Xq, Uq )X

X / (x0) dxxdx0 + J o)0 (a?0, и0) / (a?0) Ar0, (1.24)

гдг о), o)f, /f, /— положительные функции. Тогда J? —

минимум Jr достигается на функциях и\(х\)> £ = 0, ...

..., г, определяемых рекуррентными уравнениями

J г (хг) = min {J со (жг+1) /г (жг +1, Жг, Wr) dxr+i -f-

+ «г fan Mr) | Wr S <2/r}i (1.25)

Jr-г (sr-i) = min {J Jr (xr) /r-1 (жГ1 жг_ь Иг-х) Arr +

+ COr_! (^r_b Wr_i) I Wr_! G= 3/r-l}, (1.26)

/0 (я0) = min {J J1 (xx) /0 (x^ x0, u0) dxx +

+ co0 (x0, u0) I u0 <= 3/0}> (1-27)

•f? = J-M*o)/(*o)**o- (I-28)

32 ОПТИМИЗАЦИЯ ДИСКРЕТНОГО УПРАВЛЕНИЯ (ГЛ. 1

Доказательство проведем по индукции. При

г = 0 ...j*v>^»

/0 = J о (хх) /0 (xv x0, u0) f (x0) dxxdx0 +

+ J о)0 (а?0, г/0) / (а?0) йя0 = J [ J со (я?!) /0 (slf x01 и0) йхх +

+ ю0 (я?0, и0)] / (а?0) cte0. (1.29)

Для мипимизацпи /0 достаточно для каждого х0 выбором

функции и>1(х0) минимизировать функцию от х0,

заключенную в квадратные скобки в правой части (1.29).

Поэтому

/0 (х0) = min {j* о (хх) /0 {xv x0, щ) dxx +

+ со0(;г0, и0) | и0 € <W0},

Л = J J0(*o)/(*o)"d*o

и лемма доказана при г = 0.

Допустим, что лемма справедлива при r = fc. Покажем

ее справедливость при r = fc + l. Из (1.24) видно, что

величина/г зависит от функций о, о)г, ..., со0. Поэтому для

любого г можно записать /г = /г(й), ог, ..., о)0). Из (1.24)

при г = /сиг = /с + 1 видно, что

/А+1(о), 0А+1, ..., о)0) = Л(г|>, о)л, ..., ю0),

где .

•ф = -ф (#А+1, ил+1) =*

= J 0 (Xk+ъ) fk+l (#ft+2> #ft+l» ^ft+l) dXk+2 + Ю/t+l (#fc+i, Mft+i)

В соответствии со сделанным допущением о

справедливости леммы при г ==■ к получим, что величина Jt —

минимальное при фиксированном иА+1 значение

Л(г|), o)ft, ..., о)0) определится цепочкой уравнений (1.25) —

(1.28), если положить г = Тс и (д(хк+1) —тЗр(хк+и uk+i); при

этом величина /° будет зависеть от uk+i. J\ = Jk(uh+i)-

Из леммы 1.1, применяемой последовательно снизу вверх

к упомянутой цепочке уравнений (1.25)—(1.28), следует,

что для достижения минимума функции Jk(u>k+i)

параметр uk+l надо выбирать из условия минимизации

функции \|>(#ft+1, uk+l) и, следовательно, он должен быть

функцией только xh+l: uh+i = uh+l(xk+i).

§1.5] ОПТИМИЗАЦИЯ ПРИ ПОЛНОЙ ИНФОРМАЦИИ 33

Обозначив через Jk+i (xh+i) минимум ty(xk+i, uk+i),

получим, что при г = к +1 первым в цепочке

рекуррентных равенств должно быть равенство

Jl+1 (xk+1) = min { j о (яА+2) fh+1 (Жл+21 Жл+Ь Mfe+1) rf^+2 +

+ 0fe+i (Xk+1, Uk+1) I Ufe+1 S %+i}.

Лемма доказана.

§ 1.5. Уравнения оптимизации при полной

информации о фазовых координатах

Найдем вначале уравнения оптимизации

терминального стохастического управления. В этом случае со* = О

и S = М[©(#у)]. Обозначим р{хт), р(х0) плотности

вероятностей векторов хт, х0] р(хт, xN, ..., х0) — совместная

плотность вероятности векторов хт, xN, ..., х0. Тогда

S = S (и0, ..., М = J со {хт) р (хт) dxT,

где

Р [хт) = ) Р (xTi xN, ..., х0) dxN ... dx0.

Но в соответствии со сформулированным в § 1.2

условием на случайные шумы hit) при фиксированных

векторах управления последовательность случайных векторов

#о, ..., xNj хт должна быть марковской. Поэтому

р\Хт, Xjsr, . . ., Xq) =

=*pT(xT/xNi ия)ря(Хн/Хп-ь UN-i) ...piiXi/Xo, Щ)р0(х0)

и, следовательно,

S (и0,..., ил) = J о) (жг) рг (яг/sjv, uN) pN (xN/xN-l7 uN^)...

... Pi (xjx* Щ) p? {x0) dxT .. .dx0. (1.30)

В (1.30) все подынтегральные функции положительны.

Кроме того, считаем, что в моменты th, k — N, ..., 0Т

зафиксированы векторы обратной связи #0, ..., хк и,

следовательно, вектор управления может быть их функцией:

Uh — Mfctefc, . . ., Xq).

Для минимизации величины среднего риска S(u0, ...

..., uN) применим лемму 1.2, в формулировке которой

функции (o(xr), fk(xh+u xk, uk) следует заменить

соответственно На С0(#г), Pk+l(xk+i/xh, Uh) И ПОЛОЖИТЬ G)t = 0.

3 И. А. Богуславский

34 ОПТИМИЗАЦИЯ ДИСКРЕТНОГО УПРАВЛЕНИЯ [ГЛ. i

В результате получим, что векторы оптимального

управления и\ являются функциями только векторов xk:

u°k = u°k(xk), Л = 0 ЛГ, (1.31)

и определяются рекуррентными уравнениями

Sjv (%n) = niin jj о (x) pT (x/xN, u) dx \ и е %v/, (1.32)

S°n-i (zn-i) = min {J S% {x) pN (лг/зд-ь и) dx \ и s %v-i},

(1.33)

S°Q (xQ) = min {j 5? (a?) p2 (a?/a?0, u)dx\u<= <U0). (1.34)

Минимальные средние терминальные потери S°

определяются соотношением

S° = §S°0(x)p0(x)dx0. (1.35)

Рассмотрим теперь уравнения оптимизации при

использовании общего критерия (1.4). В этом случае

S (и0, ..., uN)=J о (хт) рт (хт) dxT -f

+ J cojv (*jv, wjv) Pn (sjy) dsjv + ■. - + J ©oK» Mo) Po (*o)d*0=

= J о (sr) Pr {xTlxNy uN) ...p± (xjxv u0) p0 (x0) dxT. ..dx0+

-f J о (xN, uN) pN (xn/xN-u ujv-i) ... p± (xx/x0, u0) p0 (x0) x

X dxN ... dx0 + ... + J Oi (a?i, их) px (V^o» wo) P(xo)dxxdx0+

+ J ©o (*o. wo) Po (*o) d*o- (1-36)

Применяя при минимизации лемму 1.2, получим (1.31) и

Sjv (#jv) = min {J ю (#) рг (#/#iv, и) do: +

+ on (*jv, и) | u <= <2/*}, (1.37)

S#-i (sjv-i) = min {J S% (x) pN (x/xn-i, u) dx +

i}> (1-38)

5? (a?0) = min {j 5? (ж) ^ (x/x0, u) dx +

+ co0(s0, и)|!*е1/0}. (1.39)

Величина 5° определится формулой (1.35).

§ 1.6] ОПТИМИЗАЦИЯ ПРИ НЕПОЛНОЙ ИНФОРМАЦИИ 35

Из вышеизложенного следует, что величина Sk(x)

равна среднему риску при управлении на интервале

времени (tk, T\ с использованием оптимальных управлений

ulj ..., и% и при условии того, что в момент tk вектор фа-»

зовых координат равен х. Поэтому в дальнейшем

функции Sm(x) будем называть минимальными условными

средними рисками. Этот же термин (без слова

минимальный) сохраним и для функций Sh(xk), получаемых при

использовании каких-то (неоптимальных)? управлений

uh, ..., uN. Часто функцию Si (x)^ называют функцией

Беллмана задачи (1.6).

§ 1.6. Уравнения оптимизации

при неполной информации о фазовых координатах*

Принцип разделения

Найдем уравнения оцтимизации стохастического

управления при поступлении в моменты времени f0, ...

..., tkl ..., tN статистической информации о фазовых

координатах: Z-мерных векторов обратной связи у0, ...

••■•» Ук, ..., 1Jn, статистически связанных с векторами

#о, ..., xkj ..., xN. Последнее означает, что

рЫУь ..., Уо) Ф р(хк), к = 0, ...., N.

В общем случае, по-видимому, невозможно построить

рекуррентный процесс определения оптимальных векторов

управления uk в виде

u°k = u°k(yk,...,y0). (1.40)

Кроме того, формула (1.40) описывает и\ функцией

увеличивающегося числа переменных, что делает

нереальным ее использование при решении прикладных, задач

управления.

Рекуррентные уравнения оптимизации и векторы

оптимальных управлений в виде, пб крайней мере в

принципе, пригодном для решения прикладных задач,

удается получить при выполнении следующих условий:

1. Условная плотность вероятности p(xjykl ..., у0) —

носитель всей информации о векторе хк, содержащейся

в векторах измерений ук, ..., j/0, может быть

представлена некоторой известной функцией от хк и вектора Dk,

зависящего от ук, ..., у0:

рШУъ ..., yo)=pk(xk/Dk), (1.41)

3*

36 ОПТИМИЗАЦИЯ ДИСКРЕТНОГО УПРАВЛЕНИЯ [ГЛ., 1

где Dk = Dk(ykj ♦.., у0). Вектор Dh совпадает с

определяемым в математической статистике вектором достаточных

статистик: на множестве векторов у0, ..., yh,

сохраняющем постоянным вектор Dh, распределение вектора xh

остается постоянным. Если, например, условное

распределение яА — нормальное, то компонентами Dh служат

компоненты вектора условного математического

ожидания (м. о.) и элементы условной корреляционной

матрицы (к. м.). В более сложном случае компонентами

вектора Dk могут быть, например, семиинварианты —

коэффициенты разложения в степенной ряд логарифма

характеристической функции условной плотности p(xk/ykl ...,yQ)

или квазимоменты — коэффициенты ее разложения в ряд

по полиномам Эрмита многих переменных, ортонормиро-

ванных относительно некоторой многомерной нормальной

плотности вероятности.

2. При фиксированных векторах ик

последовательность векторов Dk является марковской:

ph+l(Dk+l/Dk, ..., Do) = PwWk+i/DJ. (1.42)

Легко видеть, что (1.42) выполняется, если векторы

Dh определяются рекуррентными формулами

Dk+i = D(yk+ilDh, uh), (1.420

и в (1.2) igk — независимые случайные векторы (модель 1)

или !к = 0 (модель 2). Действительно, в

соответствии с (1.1)

#А+1 = ф(ял, ик, h, fA), (1.43)

где ф — некоторая функция от xh, ик, th и функционал от

белых шумов /г, возмущающих динамическую систему на

интервале (£А, £л+1). Тогда из (1.42'), (1.2)

Dk+l=D(H{tk+u <pUA, ик, h, tk), gfc), Dkl uk). (1.44)

Но по условию (1.41) условное распределение xh зависит

лишь от Dk. Отсюда следует (1.42). Формулы вида (1.420

можно назвать алгоритмом рекуррентной фильтрации.

«Полнота» использования зафиксированной к моменту

tk информации (векторов у0, ..., ук) не уменьшится, если

векторы и^ искать не в виде (1.40), а в вцде

u°k = ul(Dkf...,DQ). (1.45)

Равноценность (1.40) и (1.45) следует из (1.41).

§ 1.6] ОПТИМИЗАЦИЯ ПРИ НЕПОЛНОЙ ИНФОРМАЦИИ 37

Вывод рекуррентных уравнений оптимизации

проведем вначале для терминального критерия. Из (1.41),

(1.42) следует, что

р(хт, DN, ..., D0) =pT(xT/DN, uN)pN(DN/DN^, uN-x)...

...PilDJDo, и0)РоШ, (1.46)

где

pT (xT/DN, uN) = J pT {xtIxn, un) p (xn/Dn) dxN. (1.47)

Отсюда

S (uN, ..., u0) = J со (хт) р (xT) dxT =

= J со (xT) p (xT, DN, ..., D0) dxTdDN ... dDQ =

= J со (xT) pT (xT/DNl uN) pN (Dn/Dn-ц i/iv-i) . • •

... рЛВД>о. "o) Po (Do) dxTdDN ... dD0. (1.48)

Из (1.48) следует, что для минимизации S(uN, ..., щ)

можно использовать лемму 1.2, если положить функции

G)0rr+1), /r(#r+i, xr, uN), fh(xh+l, xh, uN) в (1.24) соответст-

венно равными (д{хт), pT(xT/DN, uN), ph+i(Dk+l/Dk, uk) и

u), = 0. Тогда получим, что оптимальные управления

имеют вид

ul = ul(Dh) (1.49)

и определяются рекуррентными уравнениями

S°n (DN) = min {j* со (#) рт (x/DN, u)dx\u s^jv}, (1.50)

Si.!фл-О = min{§S°N(D)pN{DIDN-x, u)dD\u<= <UN-i},

(1.51)

S°0 (Ц) = min {j Si (D) px (£>/£>„, u)dD \ и <= °U^. (1.52)

Минимальный средний терминальный риск S°

определится формулой

S* = $S°0(D)p0(D)dD. (1.53)

Частный случай рекуррентных уравнений (1.50)—

(1.52) (для линейных динамических систем) был

получен в [81.

38 ОПТИМИЗАЦИЯ ДИСКРЕТНОГО УПРАВЛЕНИЯ 1ГЛ. i

Найдем рекуррентные уравнения оптимизации при

использовании общего критерия (1.4). При этом наряду с

(1.47) учтем, что

р{хк, Dk, ..., D0) =

= pk{xk/Dh)ph(Dk/Dh-u uk-i) ...piiDJDo, u0)p0(Dt)

и, следовательно,

P Ш = J Ph {XklDh) pk {DklDu-ъ Wft-i) ...

...px {DJD„ щ) p0 (D0) dDk... dD0.

Тогда получим

S (и0, ..., uN) = J со (хт) р (xT) dxT +

+ J o)jv (xN, uN) p (xN) dxN + ... + J o)0 (xQ, u0) p (x0) dx0=

= J © (*г) Рт (xt/DNj un) pN (DNfDN-U uN^x) ...

... p± (D±/D0, u0) p0 (D0) dxTdDN ... dD0 +

+ J ®n{Dn, uN)pN (DN/DN-U un-x) ...

... Pi (DJD» u0) Po (D0) dDN...dD0+ ...

... + j 5X (Du ux) Pl (Dx/D0% u0) Po (D0) dDxdD0 +

+ j co0 (D0, u0) pQ (D0) dD0,

где положено

«a (Dk, uk) = J coA (x, uh) pk (x/Dk) dx. (1.54)

Из леммы 1.2 следует, что векторы оптимального

управления (1.49) определяются при последовательном

решении рекуррентных, уравнений

S% (DN) = min {j со (x) pT (x/DNl и) dx +

+ cojv(DN, u)\ue= 3/jv}, (1-55)

Sjlr-i (Dn-г) = min {j S% (D) pN (D/DN-19 u) dD +

+ COiV-i (DN-1, W)|WG <Un-1 }, (1-56)

S°0 (Z)e)=min{J S? (D) Pl {DID,, u) dD + w0 (Dot u)\u e= ^„}

(1.57)

§ 1.6] ОПТИМИЗАЦИЯ ПРИ НЕПОЛНОЙ ИНФОРМАЦИИ 39

Минимальный средний риск S0 определится формулой

(1.53). Функция SkiDk) в дальнейшем называется

условным средним риском, так как она представляет

средний риск при управлении на отрезке [th, T] с

использованием векторов управлений г/°, ..., и% и при условии, что

в момент tk вектор достаточных статистик равен Dh. Эту

функцию (как и введенную в § 1.5 функцию S0k(xk))

называют также функцией Беллмана.

Итак, показано, что выполнение условий 1, 2 для

произвольных динамических систем, возмущаемых

белыми (или дискретными белыми) шумами при измерениях

векторов обратной связи со случайными независимыми

векторами ошибок измерений, обеспечивает

применимость так называемого «принципа разделения»: общий

алгоритм оптимального дискретного стохастического

управления делится на алгоритм обработки поступающей

информации и алгоритм принятия решения (рис. 1.1).

"и

Алгоритм

принятия

решения

БЦВМ

Р(Вк„/ик,Вк)

~3

Х- ^з ^з

£ ^ 2

§ 5 g

jH,~>y,>g0

Рис. 1.1.

Первый алгоритм должен последовательно определять

векторы достаточных статистик Dh+i в соответствии с

рекуррентной формулой (1.420 и условные плотности

вероятностей pk+i{Dh+i/Dh,uh); второй алгоритм должен строить

векторы оптимальных управлений путем

последовательного решения рекуррентных уравнений (1.55) — (1.57) при

co(Z)A, ик) из (1.54).

Отметим, что для задачи стохастического управления

линейными системами принцип разделения впервые был

сформулирован в [60].

40 ОПТИМИЗАЦИЯ ДИСКРЕТНОГО УПРАВЛЕНИЯ [ГЛ. 1

§ 1.7. Оптимальная оценка фазовых координат

и дуальное управление

В изложенной выше трактовке задача синтеза

оптимального стохастического управления не требует

постановки и решения задачи оценки фазовых координат.

Задача оценки зависит от выбранного критерия качества

оценивания и, как видно, непосредственно не связана с

задачей управления (по крайней мере в формальном

плане). Поэтому задача оценки решается для того, чтобы

«знать», а не для того, чтобы «управлять». Однако

умение определять векторы достаточных статистик позволяет

решать задачу оценивания, оптимального по

произвольному критерию.

Пусть векторы управлений — произвольные функции

векторов обратной связи и качество оценки вектора хк

определяется средним значением положительной

функции потерь coUfc, z), где z — вектор оценки вектора xh:

z = z(yo, ..., yh). (1.58)

Тогда вектор оптимальной оценки zk решает задачу

S°=*mm{Sk(z)\z = gn}, (1.58')

где

Sk(z) = M [©(**,*)]• (1.59)

Но

Sk (z) = М [М [со (*„, z)/y0, ...> ук]] (1.60)

и из (1.41)

М [со (zh, z)/y0, ..., yh] = М [со (xhl z)/Dk], (1.61)

где в (1.60) и далее символ M[..JW] означает

осреднение при фиксированном W. При выбранных управлениях

векторы у о, ..., ук не зависят от векторов оценок.

Поэтому из (1.60) и (1.61) получим, что вектор оптимальной

оценки zk (Dh) определится при решении задачи

S°k (Dk) = min {M [со (xh, z)/Dk) \ z g= <Tn}. (1.62)

Итак, если решена задача определения достаточных

статистик Dk и условных плотностей вероятностей

p(xh/Dk), нужных для вычисления М [со(^, z)lDh]> то

задача оптимальной оценки сводится к относительно

простой задаче (1.62), численно решаемой, например,

методом стохастического программирования, если на ЦВМ су-

§ 1.7] ОЦЕНКИ И ДУАЛЬНОЕ УПРАВЛЕНИЕ 41

ществует программа, генерирующая случайные векторы

xh при фиксированном векторе Dk (см. главу 2).

Наиболее часто

©(я?*, z) = to - z)TR(xk - z), (1.63)

где матрица i? положительно определена (определение

и необходимые свойства подобных матриц изложены

в § 2.3). Обозначим через zh условное (после фиксации

векторов i/o, ..., yh) м-о- вектора xk\ zk = N[[xk/Dk].

Покажем, что

zl = zh. (1.64)

Представим (1.63) в виде

со to, z) = to — zk)TR{xk — zk) +

+ 2UA- zk)TR(zk- z) + izk-zrR(zh- z)

и, следовательно,

M [со (a*, z)/Dk] = M [to -**)T# i*k - **)/Ad +

+ M[to-~z)Ti?to~z)/Z)ft]. (1.65)

Первое слагаемое в правой части (1.65) от z не

зависит, а второе — минимально при z = zkj что доказывает

справедливость (1.64). Поэтому zk называют вектором

оценки вектора xk, оптимальным по среднеквадратичному

критерию. Этот вектор не зависит от конкретного вида

матрицы R. Вектор zk — наиболее важная вектор-функция

вектора достаточны^ статистик.

Выше предполагалось, что вектор оптимальной

оценки определяется при заданных функциях — векторах

управлений. Однако можно поставить задачу управлять

системой так, чтобы получить вектор оценки, оптимальный

на множестве допустимых управлений. При этом,

конечно, надо задаться некоторым фиксированным моментом

времени th, для которого ищется вектор оценки 4»

оптимальный на множестве допустимых управлений щ, ...

..., wA-t. Пусть для определенности k=*N, в (1.4)

положим uN = z и

0)0(Яо, Щ) =»-... —G)jv-i(#tf-i, Un-i) — (b{xT)=*0, (1.66)

CdUjv, UN) =G)Utf, z). (1.67)

Из (1.55) —(1.57) следует, что вектор оптимальной оценки

zn (Dn) и векторы оптимальных управлений и0 (Djv-i),

42 ОПТИМИЗАЦИЯ ДИСКРЕТНОГО УПРАВЛЕНИЯ 1ГЛ. 1

..., u0(D0) определяется при последовательном решении

уравнений

S% (DN) = min {j со (яг, z) pN {x/DN) dx\ze= gn), (1.68)

S%^ (Z^-i)=min {j S% (D) PN {DIDN-X, u)dD \ и e= ^/jv-i},

(1.69)

Si (D0) = min {J S? (D) px (D/DQ, u)dD\us= <U0}. (1.70)

Заметим, что векторы оптимальных управлений

u%~i (Z?iv~i)» ..., ^о (^о) можно было бы по терминологии

[51] назвать векторами дуальных управлений, так как

оптимальные управления выбираются из условия

достижения наилучшей оценки —наилучшего «узнавания»

фазовых, координат системы в момент tN, в которые,

конечно, могут быть включены неизвестные параметры,

характеризующие динамическую систему. Если в (1.68)

величина S% (Djv) не зависит от DNl то управления и0, ...

..., uN-i не влияют на среднее значение о (xN, z%) и

дуальных управлений не существует.

§ 1.8. Уравнения оптимизации

при ограничениях на энергетику

В некоторых динамических системах (примером их

служат самолет, ракета, корабль с двигателем) процесс

управления сопровождается уменьшением скалярной

величины W, которую можно назвать энергетикой системы.

В момент t0 система располагает некоторой начальной

энергетикой VF0, далее, эйергетика уменьшается в