Текст

APPLIED MATHEMATICS AND COMPUTATION

A Series of Graduate Textbooks, Monographs, Reference Works

Series Editor: Robert Kalaba, University of Southern

California

PATTERN RECOGNITION PRINCIPLES

Julius T. Tou

Center for Information Research

University of Florida. Gainesviile

Rafael С Gonzalez

Department of Electrical Engineering

University of Tennessee, Knoxvllle

Addison-Wesley Publishing Company

Advanced Book Program

Reading, Massachusetts

London-Amsterdam-Don Mills, Ontario-Sydney-Tokyo

1974

Дж. Ту, Р. Гонсалес

Принципы распознавания

образов

Перевод с английского И. Б. Гуревича

под редакцией Ю. И. Журавлева

Издательство «Мир» Москва 1978

УДК 519.92

В книге представлены методы построения распознающих си-

систем и систем обработки больших информационных массивов.

Рассматриваются основные постановки задач и важнейшие мо-

модели алгоритмов (комбинаторно-логические, статистические и

лингвистические). Изложение ведется на достаточно высоком

уровне математической строгости.

Особенность книги состоит в том, что рассматриваемые про-

проблемы авторы трактуют в тесной связи с задачами эффективной

обработки информации, причем теория распознавания выступает

как самостоятельное направление прикладной математики со

своими задачами, аппаратом и методологией.

Книга может быть использована в качестве учебного посо-

пособия по математическим методам обработки информации, а также

как справочное пособие для теоретиков и для тех, кто в своей

практической работе сталкивается с задачами обработки инфор-

информации.

Редакция литературы по математическим наукам

апппл поо © 1974 by Addison-Wesley Publishing Company. Inc.

T 2Q-78

041 @l)-78 " © Перевод на русский язык, «Мир», 1978

ПРЕДИСЛОВИЕ РЕДАКТОРА ПЕРЕВОДА

Предлагаемая вниманию читателя книга известных амери-

американских ученых Дж. Ту и Р. Гонсалеса содержит в форме, до-

доступной для широкого круга специалистов, некоторые из основ-

основных идей и методов математической теории распознавания и

классификации. Эта теория, включая ее применения к разнооб-

разнообразным прикладным задачам, является одной из наиболее

активно развивающихся областей прикладной математики и

математической кибернетики. В рамках указанной теории сло-

сложилось несколько весьма общих нацравлений. Они описаны

здесь с достаточной для математика степенью строгости и в то

же время сопровождаются большим числом примеров и обшир-

обширных комментариев, что позволяет специалисту-прикладнику при-

применять описываемые методы, не изучая во всех тонкостях мате-

математический аппарат.

Большая часть монографии посвящена описанию «классиче-

«классической» задачи распознавания. При ее постановке предполагается

следующее: объекты .распознавания заданы набором признаков,

известно некоторое число эталонных объектов, и их описания

составляют исходную (обучающую) информацию. На основе

этой информации синтезируется алгоритм, определяющий для

вновь поступивших объектов, к какому (или к каким) из конеч-

конечного числа классов они принадлежат. Авторы подробно описы-

описывают статистический подход к задачам распознавания, основан-

основанный на хорошо известных результатах о выборе из конечного

числа конкурирующих гипотез, и детерминистские методы распо-

распознавания— методы потенциальных функций. Вне внимания

авторов остаются логические и алгебраические методы. Впро-

Впрочем, в книге приведены описания отдельных алгоритмов.

Большое внимание уделено отбору признаков, используемых

для описания объектов. Хорошо известно, что удачный выбор

признаков во многом определяет успешность решения задач

распознавания. В монографии освещена большая часть матема-

математических методов реализации такого выбора.

В конце книги дано краткое описание сравнительно новых

методов — структурных, или формально-лингвистических. По-

Появление этих методов обусловлено тем обстоятельством, что

во многих случаях информацию о классах нецелесообразно

6 Предисловие редактора перевода

задавать перечислением известных объектов класса. В таких об-

областях, как алгебра, математическая логика и теория множеств,

хорошо известен и давно применяется другой способ: задаются

базисные элементы и правила порождения новых элементов.

Именно так задается каждый из классов, рассматриваемых в

задаче распознавания. При появлении нового объекта требуется

установить, может ли он быть сконструирован из заданных

базисных элементов при помощи заданных операций. Возникаю-

Возникающие при этом методы и алгоритмы являются, по существу,

переложениями соответствующих методов дискретной матема-

математики. По нашему мнению, для глубокого изучения структурных

методов распознавания и особенно для подготовки к самостоя-

самостоятельной работе необходимо освоить предварительно хотя бы

основы математической логики, теории формальных систем,

современной алгебры. К сожалению, в настоящее время струк-

структурные методы развиваются в основном для решения конкретных

задач. Более или менее общие методы в данном направлении

пока не созданы, и их создание вряд ли возможно без при-

привлечения к этой работе специалистов по дискретной матема-

математике. В настоящей монографии отмечаются трудности, которые

надо преодолеть для создания таких методов, и отдельные воз-

возможные пути развития теории.

В заключение следует отметить, что читатели в целом по-

получат интересную книгу. Она полезна студентам и аспирантам,

специализирующимся по прикладной математике и математиче-

математической кибернетике, а также инженерам, биологам, химикам, ме-

медикам, геологам, социологам и другим лицам, интересующимся

задачами классификации, распознавания и прогнозирования.

Ю. И. Журавлев

ПРЕДИСЛОВИЕ РЕДАКТОРА СЕРИИ

«ПРИКЛАДНАЯ МАТЕМАТИКА И ВЫЧИСЛИТЕЛЬНЫЕ

ПРОЦЕССЫ»

Команды современных ЭВМ выполняются в течение наносе-

наносекунд. Это позволяет быстро и точно решать системы, составлен-

составленные из нескольких сотен обыкновенных дифференциальных

уравнений. Как, однако, эти поразительные возможности ЭВМ

могут повлиять на решение тех научных, технических, экономи-

экономических и социальных проблем, с которыми сталкивается чело-

человечество? Для ответа на этот вопрос несомненно требуются

значительные усилия.

В некоторых областях человеческой деятельности мы еще

не в состоянии составлять уравнения, достаточно точно описы-

описывающие изучаемый процесс. В таких случаях вычислительную

машину можно использовать просто для получения модели про-

процесса и, возможно, оценки эффективности различных систем

управления. Есть области, в которых математическое описание

не составляет проблемы, но численное решение соответствующих.

уравнений оказывается затруднительным. В подобных случаях

следует попытаться честно преодолеть возникшие сложности;

если же эти попытки не приведут к успеху, то надо постараться

отыскать описание, в большей степени соответствующее возмож-

возможностям вычислительных машин. Математика предоставляет

почву для применения такой стратегии и в свою очередь пи-

питается ее плодами.

Каждый раз, когда быстродействие и размер памяти вы-

вычислительных машин увеличиваются на порядок, необходимо

производить переоценку вычислительных методов и классов

задач, входящих в категорию поддающихся решению. В книгах,

включенных в данную серию, представлена современная точка

зрения на постановку, анализ с использованием математического

аппарата и машинное решение соответствующих задач.

Задачи распознавания образов возникают во многих обла-

областях— в качестве примеров можно назвать медицинскую диагно-

диагностику, перевод и статистику. Настоящая книга вводит читателя

в круг основных идей и методов распознавания образов и спо-

способствует дальнейшему развитию этого направления приклад-

прикладной математики, переживающего пору расцвета.

Роберт Калаба

Посвящается нашим женам

Лизе Ту и Конни Гонсалес

ПРЕДИСЛОВИЕ

Эта книга написана с целью снабдить инженеров, исследо-

исследователей и студентов, занимающихся проблемами анализа дан-

данных и обработки информации, исчерпывающим, упорядоченным

и современным руководством, излагающим основные принципы

и практические методы анализа и распознавания образов, а

также синтеза соответствующих систем.

Первые попытки изучения возможностей автоматизации про-

процесса распознавания образов относятся к началу 50-х годов,

когда цифровые вычислительные машины постепенно стали

общедоступным средством обработки информации. Часть этих

первоначальных работ в области распознавания образов была

посвящена разработке программ автоматического принятия реше-

решений и созданию специализированной аппаратуры, предназначен-

предназначенной для автоматического «чтения» образов типа печатных бук-

буквенно-цифровых знаков. В конце 50-х годов Розенблатт предло-

предложил перцептронный алгоритм, который представлял собой одну

из первых моделей процессов запоминания и организации ин-

информации, реализуемых мозгом. В этот период ведущие подходы

к решению задач распознавания были основаны на идеях теории

статистических решений и пороговой логики. Исследования в

области синтеза систем распознавания набирали темп на протя-

протяжении 60-х годов по мере того, как расширялось использование

вычислительных машин и становилась очевидной потребность

в более быстрой и эффективной связи человека с ЭВМ. Для того

чтобы при решении некоторых типов задач распознавания зри-

зрительных образов можно было пользоваться результатами теории

машинных языков и соответствующими возможностями обра-

обработки информации, был предложен синтаксический подход как

дополнение к аналитическим методам.

Основные концепции теории распознавания приобретают все

большее признание в качестве фактора, существенного для по-

построения современных информационных систем, реализованных

на основе вычислительных машин. Интерес к этому направлению

продолжает быстро расти — соответствующие задачи являются

объектами междисциплинарных исследований, проводимых в

рамках столь различных областей, как техника, вычислительная

математика и кибернетика, теория информации, статистика,

Предисловие

физика, химия, лингвистика, психология, биология, физиология

и медицина. В каждой из них основное внимание уделяется

какому-то конкретному аспекту задачи распознавания — от мо-

моделирования физиологических процессов до развития аналити-

аналитических методов автоматического принятия решений. Колоссаль-

Колоссальный материал, связанный с теорией распознавания образов и ее

приложениями, рассеян по всевозможным техническим журна-

журналам, трудам конференций, монографиям, излагающим резуль-

результаты последних исследований, и отдельным учебникам, трактую-

трактующим лишь некоторые частные подходы к решению задач распо-

распознавания. Поэтому не так уж просто,, особенно новичку в этой

дисциплине, расположенной на «стыке» других областей, усвоить

широкий спектр принципов, лежащих в ее основе. При написа-

написании данного руководства мы попытались собрать в его рамках

основные аналитические методы и фундаментальные принципы,

изложив их в определенной логической последовательности и с

единых позиций. В результате получилась книга, которую можно

использовать и как учебник, и как справочник. Для тех, кто

собирается изучать предмет, она позволяет последовательно

ознакомиться с основными теориями и важнейшими методами.

Для инженеров и исследователей — это удобный источник систе-

систематически организованного справочного материала.

Предполагается, что читатель обладает соответствующей

подготовкой в области программирования, статистики, теории

матриц и математического анализа. При изложении материала

основное внимание уделяется получению фундаментальных ре-

результатов, опирающихся на основные концепции теории. В текст

включен разбор многочисленных примеров, а в конце каждой

главы приводятся упражнения, имеющие самый различный ха-

характер и сложность. Часть этих задач предназначена для того,

чтобы читатель в процессе их решения мог лучше уяснить от-

отдельные обсуждавшиеся положения, другие служат дополнением

или продолжением материала основного текста.

Настоящая книга основана непосредственно на конспектах

лекционных курсов, прочитанных авторами в Университете

штата Флорида и Университете штата Теннесси. Первый ва-

вариант этих конспектов появился в 1962 г., когда читался трехме-

трехмесячный курс в Северо-западном университете; позднее тот же

материал был прочитан в Университете штата Огайо. Различные

варианты этого курса были «опробованы» на студентах, специа-

специализирующихся в области вычислительной математики и кибер-

кибернетики и электротехники, что позволило тщательно отобрать

материал. Советы и критика, высказанные студентами на лек-

лекциях, привели к существенному изменению исходной рукописи.

Мы выражаем признательность целому ряду лиц, непосред-

непосредственно или косвенно содействовавших подготовке книги.

10 'Предисловие

В частности, мы хотели бы поблагодарить профессоров

У. X. Чжэня, Дж. М. Гуджа, Дж. Ф. Пирса, М. Дж. Томасона,

К. К. Ли, К. С. Фу, д-ра Р. К. Крайтера, д-ра П. X. Суэйна,

К. У. Суонгера, д-ра Нила Вальда и Г. К. Геррана. Мы хотели

бы также поблагодарить Мэри Бэрден, Грейс Серл, Дебру Дил-

лингхам, весь секретарский состав Университета штата Флорида

и Университета штата Теннесси за перепечатку многочисленных

вариантов рукописи. Кроме того, мы выражаем свою призна-

признательность за финансирование наших исследований в области

обработки информации и распознавания образов Управлению

научно-исследовательских работ ВМС США, Научно-исследова-

Научно-исследовательскому управлению сухопутных войск США, Национальному

управлению по аэронавтике и исследованию космического про-

пространства США, Окриджской национальной лаборатории и На-

Национальному научному фонду США.

Джулиус Т. Ту

Рафаэл К. Гонсалес

Глава 1

ВВЕДЕНИЕ

Несколько лет назад в воскресном выпуске газеты «Нью-

Йорк тайме» был задан следующий вопрос: «Облегчит ли поло-

положение маклерских фирм, все служебные помещения которых пе-

переполнены документами, сокращенный рабочий день?» Далее

сообщалось: «Профессор психологии Гарвардского университета

предупреждает, что к 2000 году возможности человеческого

мозга воспринимать информацию могут оказаться исчерпан-

исчерпанными. „Быть может, наименее способные из нас в каком-то

смысле уже близки к этому пределу, — заявил он, — потребность

же в тех, кто все еще в состоянии справляться с современным

уровнем сложности, все время увеличивается"». Впрочем, теку-

текущую прессу мало заботит информационный взрыв.

В последнее время в нашем весьма сложном технологически

ориентированном обществе создалось такое положение, при ко-

котором все большее количество людей и организаций занимаются

обработкой информации и все меньшее — обработкой мате-

материальных объектов. Ощутимой стала потребность в более совер-

совершенных информационных системах, поскольку информация —

ключевой элемент процесса принятия решений, а количество

разнохарактерной и разной степени сложности информации,

которую порождает наш мир, растет. Одной из важнейших за-

задач, возникающих в связи с созданием современных информа-

информационных систем, является автоматизация процесса распознава-

распознавания образов. Именно этой проблеме и посвящена наша книга.

1.1. ПРОБЛЕМА ОБРАБОТКИ ИНФОРМАЦИИ

Прогресс «технологической» цивилизации и развитие науки

породили информационную проблему, с которой столкнулось сей-

сейчас человеческое общество. У первобытных людей такой про-

проблемы не было. В самом деле, уровень развития общества

можно оценить количеством генерируемой им информации и

знания. Без информации цивилизация, как мы ее понимаем, су-

существовать не может. Решение современных социальных проб-

проблем также зависит от разрешения информационной проблемы.

Информационный взрыв — один из наиболее драматических вы-

12 Гл. 1. Введение

зовов, угрожающих нашему обществу в 1970-х и 1980-х годах,

причем темп роста этой угрозы будет продолжать увели-

увеличиваться.

Проблему информационного взрыва хорошо иллюстрирует

следующая статистика. В 1830 г. выходило около 300 техниче-

технических и научных журналов. Сегодня во всем мире на более чем

50 языках в год выходит свыше 60 000 журналов, содержащих

около 2,5 миллиона статей. Ежегодно во всем мире выпускается

в свет около 80 000 новых названий книг. Ежегодно через банки

проходит около 20 миллиардов чеков, причем каждый обраба-

обрабатывается 4—5 раз. Ведущие банки выполняют в день около

25 миллионов операций. Министерство почт Соединенных Шта-

Штатов очень серьезно озабочено проблемой почтовой корреспонден-

корреспонденции. В настоящее время в почтовых отделениях США за одну

секунду обрабатывается около 27 000 единиц почтовых отправ-

отправлений; это соответствует 84 миллиардам в год, а к 1980 г. ожи-

ожидается увеличение этой цифры до 116 миллиардов. Главный

почтмейстер заявил несколько лет назад в подкомитете конгрес-

конгресса: «Откровенно говоря, наше министерство состязается в ско-

скорости с надвигающейся катастрофой».

В архивах федеральных служб Соединенных Штатов в на-

настоящее время хранится более 200 миллионов отпечатков паль-

пальцев и около 150 миллионов счетов по выплатам в рамках

системы социального обеспечения. В 1940 г. было зарегистриро-

зарегистрировано всего 15 миллионов налоговых деклараций — в 1973 г.

Налоговое управление обработало уже свыше 100 миллионов

налоговых деклараций и 360 миллионов единиц соответствую-

соответствующих документов. Налоговое управление ожидает, что к 1980 г.

число налоговых деклараций достигнет 137 миллионов. Про-

Проблема объема операций осложняется еще и тем обстоятель-

обстоятельством, что налоговая система в Соединенных Штатах регули-

регулируется довольно сложным законодательством и отражает по-

постоянно увеличивающееся разнообразие финансовых сделок.

Проблемы, встающие перед медициной в связи с информа-

информационным взрывом, аналогичны тем, которые сегодня возникают

и в других направлениях деятельности общества. Врачи начи-

начинают ощущать, что они не в силах эффективно справляться с чу-

чудовищными информационными потоками, поступающими к ним

при медицинском обслуживании населения и при исследова-

исследовательской работе. Для того чтобы поставить правильный диагноз

и назначить соответствующее лечение, врач должен опросить

и обследовать пациента, провести лабораторные и другие иссле-

исследования и зарегистрировать собранную информацию. Он должен

отобрать, проверить и сопоставить полученные данные с соб-

собственным опытом и на этой основе поставить диагноз, идентифи-

идентифицирующий заболевание. Как при диагностике, так и при лечении

/./. Проблема обработки информации 13

врач постоянно занят анализом и обработкой информации, что

и позволяет^ ему достичь соответствующие медицинские цели.

Если бы в процессе повседневной работы он мог без чрезмерных

сложностей использовать медицинскую информационную си-

систему для выборки и хранения клинических данных, аналитиче-

аналитические возможности и быстродействие такой системы способство-

способствовали бы расширению профессиональных возможностей врача.

Применительно к обслуживанию пациентов медицинский работ-

работник смог бы молниеносно восстановить всю необходимую меди-

медицинскую информацию и информацию о способах лечения в

форме, максимально удобной для эффективного использования.

Сталкиваясь с нестандартным заболеванием, врач может захо-

захотеть получить таблицу статистических данных, содержащую

сотни или тысячи наборов признаков, симптомов или результа-

результатов лабораторных анализов, характеризующих больных, кото-

которым был поставлен этот же диагноз. Клинические лаборатории

нуждаются в автоматизированных системах, предназначенных

для расшифровки рентгеновских снимков, идентификации кле-

клеточных препаратов, обработки кардиограмм при массовых кар-

кардиологических обследованиях и диагностики. Больницам нужны

автоматизированные информационные системы, включающие

информационно-поисковые подсистемы для историй болезни,

подсистемы назначения процедур и подсистемы управления

больницей. Медицинские информационные системы явятся для

медиков средством, способствующим обострению их интуиции

и расширению профессиональных возможностей.

Промышленность сталкивается с насущной необходимостью

улучшить информационные связи между предприятиями. Адми-

Административный персонал и руководство компаний нуждаются в

большем количестве информации о положении внутри компа-

компаний, результатах собственной деятельности и рынке, на который

компания работает, причем информация нужна им своевремен-

своевременно— так, чтобы они могли найти наилучшее решение в условиях

быстро меняющейся конъюнктуры. Информационные системы

играют важную роль в процессах принятия решений, как на

правительственном, так и на «деловом» уровне. Окончательная

оценка таких решений всегда будет производиться человеком,

однако появившиеся концепции и методы, предусматривающие

использование вычислительных машин, обеспечивают выдвиже-

выдвижение и оценку такого количества вариантов, какое ни один руко-

руководитель не мог осмыслить. Возможность использовать, кроме

того, методы анализа риска позволяет руководителю оценивать

потенциальную опасность, связанную с каждой из множества

изучаемых стратегий. Информационные системы обеспечат ру-

руководителю возможность более ясно представлять результаты

принимаемых им решений.

14 Гл. 1. Введение

Наше счастье, что цифровые вычислительные машины —одно

из важнейших технических достижений XX в.— начинают за-

заполнять все расширяющуюся информационную «брешь». Вычис-

Вычислительная машина, отметившая только что свой тридцатый день

рождения, достигла совершеннолетия, пройдя за/ короткий срок

путь от научного курьеза до существенного элемента человеческо-

человеческого существования. История человечества не знает технического

достижения, которое в большей степени оказало бы непосред-

непосредственное влияние на человека и его образ жизни. Вычислитель-

Вычислительные машины во многих отношениях изменили представление

о времени, сместили общепринятые пределы и связи, регулирую-

регулирующие нашу жизнь и деятельность организаций, в рамках которых

она протекает, ускорили темп перемен. Только представьте, что

бы произошло, если бы разом были исключены все вычисли-

вычислительные машины из нашей жизни. Воздушное сообщение было

бы повергнуто в хаос, банки оказались бы завалены необрабо-

необработанными документами, промышленное производство распалось

бы и многое в нашей жизни из того, что мы привыкли считать

само собой разумеющимся, вдруг неожиданно испарилось бы.

Банковское дело претерпело много перемен со времени «бан-

«банковских каникул» 1933 г.1) Эти перемены привели к так назы-

называемой «банковской революции». Электронная цифровая вычис-

вычислительная машина хотя и не являлась ее причиной, но оказалась

инструментом, использованным для ее ускорения. «Банковская

революция» заключалась в признании банками существования

розничного рынка — потребностей отдельных лиц — в отличие

от приоритета, стандартно предоставлявшегося нуждам, связан-

связанным с деловой активностью, деятельностью крупных корпора-

корпораций и отдельных бизнесменов. Эта «революция» привела к росту

внимания, уделяемого индивидуальным счетам, взносам по бан-

банковским ссудам, кредитным карточкам и различным способам

привлечения сбережения с соответственно различными процент-

процентными ставками. «Революция» породила и проблему «бумаж-

«бумажного» взрыва. За последние 30 лет количество чеков, обработан-

обработанных банками, возросло более чем в 15 раз. К концу 1950-х

годов количество использовавшихся финансовых документов

и подлежащих обработке чеков увеличилось в такой степени, что

') Одним из следствий международного экономического кризиса 1929—

1933 гг. было массовое и паническое изъятие вкладчиками своих сбережений

и капиталов из банков; этот процесс в свою очередь приводил к еще боль-

большему хаосу финансовой системы. В качестве одной из мер борьбы с этим

явлением использовалось введение банковских нерабочих дней и даже недель.

6 марта 1933 г. новоизбранный президент США Франклин Делано Рузвельт,

сразу же по вступлении в должность, воспользовавшись законом военного

времени, закрыл банки, чтобы впредь до того, как конгресс сможет принять

необходимое законодательство, приостановить массовое изъятие вкладов.—

Прим. перев.

/./. Проблема обработки информации 15 .

грозило зйдушить банковскую систему Соединенных Штатов.

В этот момент на помощь пришли цифровые вычислительные

машины. ОнЦ позволили банкам быстро и с приемлемыми затра-

затратами обрабатывать огромное количество финансовых докумен-

документов, обеспечивая, таким образом, банкам возможность продолже-

продолжения роста. Кроме того, вычислительные машины использовались

в качестве мощного инструмента управления. Рост и уско-

ускорение оборота капиталов заставлял банки постоянно искать

новые рынки и новых клиентов, что приводило к еще большему

ускорению роста. Таким образом, появление вычислительных

машин действительно обеспечило увеличение темпа «банковской

революции». Именно информационная система сделала эту «ре-

«революцию» необходимой.

Проблемы, связанные со взысканием налогов, относятся к

наиболее серьезным из вызванных бумажной бурей. Налоговое

управление с нетерпением ждет появления вычислительных

машин и систем, обладающих большим быстродействием, луч-

лучшими возможностями накопления и поиска информации и наде-

наделенных способностью эффективно распознавать символы. Необ-

Необходима хорошая налоговая информационная система, которая

не только обеспечивает возможность работы в естественном мас-

масштабе времени и произвольной выборки информации, но также

благодаря наличию сети терминалов, снабженных дисплеями,

позволяет любому местному отделению получать любую необхо-

необходимую информацию буквально нажатием кнопки. Это не только

даст возможность местным отделениям своевременно отвечать

на вопросы налогоплательщиков, но и приведет к уменьшению

количества запросов налогоплательщикам, касающихся уже

предоставлявшейся ими информации.

Судя по всему, мы вступаем в эпоху, когда человек, приоб-

приобретя в качестве нового партнера созданные им информационные

системы, окажется в состоянии решать много более сложные,

чем когда бы то ни было, задачи. Этот новый вид «сотрудниче-

«сотрудничества» сделает общество более совершенным, а жизнь людей —

лучшей. Одной из важнейших проблем, возникающих в связи с

созданием современных полностью автоматизированных инфор-

информационных систем, является автоматизация процесса распозна-

распознавания образов — область, изучением которой занято множество

исследовательских групп. В их состав входят инженеры, специа-

специалисты в области вычислительной математики, кибернетики и

теории информации, физики, статистики, психологи, биологи,

физиологи, медики и лингвисты. Каждая из таких групп посвя-

посвящает свою работу какому-тЬ определенному аспекту общей

проблемы распознавания. Haiiia книга представляет собой по-

попытку обсудить фундаментальные принципы, лежащие в основе

разработки автоматических систем распознавания образов.

16 Гл. 1. Введение

1.2. ОСНОВНЫЕ ПОНЯТИЯ РАСПОЗНАВАНИЯ ОБРАЗрВ

Способность «распознавать» считается основным свойством

человеческих существ, как, впрочем, и других живых организ-

организмов. Образ представляет собой описание объекта. В каждое

мгновение нашего бодрствования мы совершаем ^кты распозна-

распознавания. Мы опознаем окружающие нас объекты и в соответствии

с этим перемещаемся и совершаем определенные действия. Мы

можем заметить в толпе друга и понять, что он говорит, можем

узнать голос знакомого, прочесть рукопись и идентифицировать

отпечатки пальцев, можем отличить улыбку от злобной гримасы.

Человеческое существо представляет собой очень сложную ин-

информационную систему — в определенной степени это опре-

определяется чрезвычайно развитыми у человека способностями

распознавать образы.

В соответствии с характером распознаваемых образов акты

распознавания можно разделить на два основных типа: распо-

распознавание конкретных объектов и распознавание абстрактных

объектов. Мы распознаем символы, рисунки, музыку и объекты,

нас окружающие. Процесс, включающий распознавание зритель-

зрительных и слуховых образов, можно определить как «сенсорное»

распознавание. Процессы этого типа обеспечивают идентифика-

идентификацию и классификацию пространственных и временных образов.

С другой стороны, мы в состоянии с закрытыми ушами и гла-

глазами опознать старый довод или найти решение задачи. Подоб-

Подобные процессы обеспечивают распознавание абстрактных объек-

объектов и их можно определить как «понятийное» распознавание в

отличие от зрительного или слухового распознавания. В данной

книге мы будем иметь дело с распознаванием первого типа.

Примерами пространственных образов служат символы, отпе-

отпечатки пальцев, синоптические карты, физические объекты и

рисунки. В разряд временных образов входят речь, переменные

сигналы, электрокардиограммы, характеристики цели и времен-

временные ряды.

Распознавание человеком конкретных образов можно рас-

рассматривать как психофизиологическую задачу, связанную с про-

процессом взаимодействия индивида с определенным физическим

раздражителем. Когда индивид воспринимает образ, он реали-

реализует процесс индуктивного вывода и устанавливает ассоциатив-

ассоциативную связь между своим восприятием и определенными обобщен-

обобщенными понятиями или «ориентирами», установленными им на

основании прошлого опыта. В сущности распознавание челове-

человеком образов можно свести к вопросу оценки относительных

шансов на то, что исходные данные соответствуют тому или

иному из известных множеств статистических совокупностей,

определяющихся прошлым опытом человека и предоставляющих

1.2. Основные понятия распознавания образов 17

ориентиры и \хприорную информацию для распознавания. Таким

образом, задачу распознавания образов можно рассматривать

как задачу установления различий между исходными данными,

причем не посредством отождествления с отдельными образами,

но с их совокупностями; последнее осуществляется при помощи

поиска признаков (инвариантных свойств) на множестве объек-

объектов, образующих определенную совокупность.

В задачах распознавания образов можно выделить два

основных направления.

1. Изучение способностей к распознаванию, которыми обла-

обладают человеческие существа и другие живые организмы.

2. Развитие теории и методов построения устройств, пред-

предназначенных для решения отдельных задач распознавания обра-

образов в определенных прикладных областях.

Первое направление связано с такими дисциплинами, как

психология, физиология и биология, второе же имеет дело в

первую очередь с техникой, вычислительными машинами и ин-

информатикой. В нашей книге речь будет идти о вычислительных

машинах, информатике и технических аспектах построения

автоматических систем распознавания образов.

Проще говоря, распознавание образов можно определить как

отнесение исходных данных к определенному классу с помощью

выделения существенных признаков или свойств, характеризую-

характеризующих эти данные, из общей массы несущественных деталей. Про-

Прогноз погоды можно интерпретировать как задачу распознавания

образов. Исходные данные в этом случае принимают вид синоп-

синоптических карт. Система интерпретирует их, выделяя существен-

существенные признаки и формируя на их основе прогноз. Постановку

медицинского диагноза также можно рассматривать как задачу

распознавания образов. Симптомы служат исходными данными

для распознающей системы, которая на основе их анализа иден-

идентифицирует заболевание. Система распознавания символов

представляет собой систему распознавания образов, в которую

в качестве исходных данных вводятся оптические сигналы и

которая индентифицирует названия символов. В системе распо-

распознавания речи произнесенное слово идентифицируется посред-

посредством анализа воспринятого системой звукового сигнала.

В табл. 1.1 перечислен ряд задач классификации, а также соот-

соответствующие исходные данные и ответы, выдаваемые системой.

Предмет распознавания образов объединяет ряд научных

дисциплин; их связывает поиск решения общей задачи — выде-

выделить элементы, принадлежащие конкретному классу, среди мно-

множества размытых элементов, относящихся к нескольким клас-

классам. Под классом, о.бдазов понимается некоторая категория, опре-

определяющаяся ррдом^свойет^^щих для всех ее элементов.

18

Гл. /. Введение

Таблица 1.1

Содержательный характер

задачи классификации

Вид исходных данных

Вид ответа системы

распознавания

Распознавание символов

Распознавание речи

Идентификация говоря-

говорящего человека

Прогноз погоды

Установление медицинско-

медицинского диагноза

Прогноз состояния фон-

фондовой биржи

Оптические : сигналы

или элементы раз-

развертки

Акустические сигналы

Голос

Синоптические карты

Симптомы заболевания

Финансовые новости и

сводки

Название символа

«Имя» слова

Имя говорящего чело-

человека

Прогноз погоды

Вид заболевания

Прогноз повышения

или понижения цен

на рынке

Образ — это описание любого элемента как представителя соот-

соответствующего класса образов. В случае когда множество обра-

образов разделяется на непересекающиеся классы, желательно

использовать для отнесения этих образов к соответствующим

классам какое-либо автоматическое устройство. Считывание и

обработка погашенных банковских чеков являются примером

задачи распознавания образов. Подобные задачи могут вы-

выполняться и людьми; машина, однако, справляется с ними много

быстрее. С другой стороны, некоторые задачи распознавания

таковы, что человек едва ли в состоянии решать их. Примером

задач такого рода служит выделение из множества морских

сигналов и шумов тона подводной лодки посредством анализа

подводных звуковых сигналов.

Очевидное, но совсем уж «бесхитростное» решение задачи

распознавания заключается в применении к отдельным предъяв-

предъявленным образам ряда простых тестов для выделения признаков

каждого класса. Совокупность этих тестов должна различать

все допустимые образы из разных классов. Рассмотрим, напри-

например, следующие четыре китайских иероглифа:

Эти простые символы можно распознать с помощью тестов, про-

проверяющих наличие вертикальной черточки, горизонтальной чер-

черточки, отдельной точки, открытой верхней части, открытой ниж-

нижней части и последовательности точек, подсчитав затем коли-

количества и последовательности черточек. В качестве второго

примера рассмотрим следующие пять английских букв:

COINS

1.2. Основные понятия распознавания образов

19

Эти буквы можно классифицировать, применив тесты на нали-

наличие таких признаков, как замкнутая кривая, изгиб, двойной из-

изгиб, вертикальный отрезок, короткий отрезок. На рис. 1.1 приве-

приведена функциональная блок-схема, иллюстрирующая описанный

подход к распознаванию образов.

Вход

Нет

Нет

Имеются ли

сдвоенные горизонтальные

черточки ?

Да

Имеются ли

вертикальные

черточки ?

Да

Имеется ли

последовательность

точек ?

Имеется ли

открытая

верхняя

часть ?

Рис. l.l. Блок-схема простой логической (вопросно-ответной) процедуры клас-

классификации символов.

Если следовать такому интуитивному подходу, то построение

автоматической системы распознавания образов может пока-

показаться довольно простой задачей. Не существует, однако, общей

теории, позволяющей определить, какие из всего множества

мыслимых тестов следует применить к предъявленным образам.

Очень ограниченное количество или небрежный выбор тестов не

дадут возможности получить характеристики предъявленных

20

Гл. / Введение

для распознавания образов, достаточные для отнесения их к со-

соответствующим классам.Слишком много тестов, с другой сто-

стороны, необоснованно усложнят вычисления, осуществляемые в

процессе дальнейшего анализа. Отсутствует какое-либо общее

правило для получения неких ориентиров, способствующих

определению набора таких тестов. Подобный подход чрезмерно

зависит от опыта и технической интуиции разработчика и по-

поэтому часто не дает удовлетворительного решения задач распо-

распознавания образов, встречающихся в практической деятельности.

Символы

букбет-щщя-

бые симболы

Буквы

английского

...

\

Арабские

цирры

•

Китайские

иероглифы

/

Дребние

• • •

Современные

Печатные\ \ Рукописные \Прописные\ Строчные[ |Печатные[ рукописные]

Рис. 1.2. Иерархия отношений между образами и классами образов.

Тщательное изучение задач, возникающих в процессе распозна-

распознавания образов, позволяет прийти к более эффективным подхо-

подходам. Именно эти задачи рассматриваются и анализируются в

нашей книге.

Между образами и классами образов существует некое

иерархическое упорядочение. Так, на схеме, приведенной на

рис. 1.2, буквенно-цифровые символы и китайские иероглифы

являются образами, а символы соответствуют классу образов.

Буквы алфавитов и цифры являются образами, если буквенно-

цифровые символы рассматриваются как класс образов. Печат-

Печатные и рукописные изображения, например, буквы А являются

образами буквы английского алфавита А, которая представляет

в этом случае класс образов. Многие информационные системы

нуждаются в устройстве для распознавания печатных букв и

цифр, набранных различными шрифтами, и рукописных букв и

цифр, написанных различными почерками. Это означает, что

имеется 62 класса образов, представляющие 26 прописных букв,

26 строчных букв и 10 цифр 1). Разнообразие наборных шрифтов

') Имеются в виду 26 букв английского алфавита. — Прим. перев.

1.3. Основные задачи, возникающие при разработке систем 21

и способов написания определенной буквы или цифры порож-

порождает образы, принадлежащие к определяющему данный символ

классу.

Остановимся на задаче распознавания письменных знаков.

Конкретная буква или цифра вне зависимости от того, как она

напечатана или написана, обладает рядом общих признаков,

которые используются в качестве средств ее идентификации.

Буквы и цифры идентифицируются и классифицируются со-

согласно отмеченным у них таким признакам. Следовательно,

основные функции системы распознавания образов заключаются

в обнаружении и выделении общих признаков образов, описы-

описывающих объекты, принадлежащие к одному и тому же классу

образов, узнавании этого образа в любой другой обстановке и

отнесении его к одному из заданных классов.

^ОСНОВНЫЕ ЗАДАЧИ, ВОЗНИКАЮЩИЕ

ПРИ РАЗРАБОТКЕ СИСТЕМ РАСПОЗНАВАНИЯ

ОБРАЗОВ

Задачи, возникающие при построении автоматической систе-

системы распознавания образов, можно обычно отнести к нескольким

основным областям. Первая из них связана с представлением.

исходных данных, полученных как результаты измерений для

"подлежащего распознаванию объекта. Это проблема чувстви-

чувствительности. Каждая измеренная величина является некоторой

"характеристикой образа или объекта. Допустим, например, что

образами являются буквенно-цифровые символы. В таком слу-

случае в датчике может быть успешно использована измерительная

сетчатка, подобно приведенной на рис. 1.3, а. Если сетчатка

состоит из п элементов, то результаты измерений можно пред-

представить в виде вектора измерений или вектора образа

х=

х2

A.3.1)

где каждый элемент *,• принимает, например, значение 1, если

через /-Ю ячейку сетчатки проходит изображение символа, и

значение 0 в противном случае. В последующем изложении бу-

будем называть векторы образов просто образами в тех случаях,

когда это не приводит к изменению смысла.

Второй пример проиллюстрирован на рис. 1.3,6. В этом слу-

случае образами служат непрерывные функции (типа звуковых

22

Гл. 1 Введение

сигналов) переменной t. Если измерение значений функций про-

производится в дискретных точках t\, t2, ..., tn, вектор образа

можно сформировать, приняв xi = f(ti), x% =f(t2), ..., х„ =

= f(tn).

Векторы образов будут обозначаться строчными буквами,

выделенными жирным шрифтом, например х, у и г. Условимся,

fit)

U U

U

: \, Х{'0until

Рис. 1.3. Две простые схемы порождения вектора образа.

что эти векторы везде будут вектор-столбцами, как в уравнении

A.3.1). Эквивалентная запись х = (*i, x2, ..., хп)', где штрих

обозначает транспонирование, будет также использоваться в

тексте.

Векторы образов содержат всю поддающуюся измерению

информацию об образах. Процесс измерения, которому подвер-

подвергаются объекты определенного класса образов, можно рассмат-

рассматривать как процесс кодирования, заключающийся в присвоении

каждой характеристике образа символа из множества элементов

алфавита {*,¦}. Когда измерения приводят к информации, пред-

представленной действительными числами, часто оказывается полез-

полезным рассматривать векторы образов в качестве точек п-мерного

евклидова пространства. Множество образов, принадлежащих

одному классу, соответствует совокупности точек, рассеянных

в некоторой области пространства измерений. Соответствующий

простой пример приведен на рис. 1.4 для случая двух классов,

обозначенных coi и ©г. В этом примере предполагается, что

1.3. Основные задачи, возникающие при разработке систем

23

классы <Di и «г представляют соответственно группы футболи-

футболистов-профессионалов и жокеев. Каждый «образ» характери-

характеризуется результатами двух измерений: ростом и весом. Векторы

образов имеют, следовательно, вид x = (a:i, х^)', где параметр

х\ — рост, а параметр л:2— вес. Каждый вектор образа можно

считать точкой двумерного пространства. К^^сд.едхехи[3_2исЛ^4,

эти два класса образуют непересекающиеся множеагвд^что

oбъяcняeJXЯ-^aдaктegOl^L и^^?Р_я5Щ.М??_Да-?9Мб1Е°й: В практи-

ч"ёскй"х~ситуациях, однако, далёко не всегда удается выбрать

. о а, -

- корост

¦ А

Рис. 1.4. Два непересекающихся класса образов.

измеряемые параметры так, чтобы получить строго непересекаю-

непересекающиеся множества. В частности, если в качестве критериев раз-

разбиения выбран рост и вес, может наблюдаться существенное,

пересеч^ниа__кддсход^,представляющих профессиональных фут-

футболистов и баскетболистов ').

Вторая задача распознавания образов связана с выделением

характерных признаков или свойств из полученных исходных

данных и снижением размерности векторов образов. Эту за-

задачу часто определяют как задачу предварительной обработки

и выбора признаков. При распознавании речи, например, можно

отличать гласные и полугласные звуки от фрикативных и неко-

некоторых других консонант, измеряя частотное распределение энер-

энергии в спектрах. Шире всего при распознавании речи исполь-

используются такие признаки, как длительность звука, отношения

величин энергии в различных диапазонах частот, расположение

пиков спектров (или формант) и их смещение во времени.

Признаки класса образов представляют собой характерные

свойства, общие для всех образов данного класса. Признаки,

характеризующие различия между отдельными классами, можно

) Авторы имеют в виду американский футбол, в котором игроки отли-

отличаются значительным ростом и весом. — Прим. перев.

24 Гл. 1. Введение

интерпретировать как межклассовые признаки. Внутриклассо-

Внутриклассовые признаки, общие для всех рассматриваемых классов, не

несут полезной информации с точки зрения распознавания и

могут не приниматься во внимание. Выбор признакоа.хчи2а§1ся

одной из важных задач, связанных с "построением распознающих,

QjjCXgM. Если результаты измерений позволяют получить полный

набор различительных признаков для всех классов, собственно

распознавание и классификация образов не вызовут особых за-

затруднений. Автоматическое распознавание тогда сведется к

процессу простого сопоставления или процедурам типа про-

просмотра таблиц. В большинстве практических задач распознава-

распознавания, однако, определение полного набора различительных при-

признаков оказывается делом исключительно трудным, если вообще

не невозможным. К счастью, из исходных данных обычно

удается извлечь, некоторые из различительных признаков и ис-

использовать их для упрощения процесса автоматического распо-

распознавания образов. В частности, размерность векторов измерений

можно снизить с помощью преобразований, обеспечивающих

минимизацию потери информации; этот метод обсуждается

в гл. 7.

Третья задача, связанная с построением систем распознава-

распознавания образов, состоит в отыскании оптимальных решающих про-

процедур, необходимых при идентификации и классификации. После

того как данные, собранные о подлежащих распознаванию об-

образах, представлены точками или векторами измерений в

пространстве образов, предоставим машине выяснить, какому

классу образов эти данные соответствуют. Пусть машина пред-

предназначена для различения М классов, обозначенных ац, сог, ...

..., сом- В таком случае пространство образов можно считать

состоящим из М областей, каждая из которых содержит точки,

соответствующие образам из одного класса. При этом задача

распознавания может рассматриваться как построение границ

областей решений, разделяющих М классов, исходя из зареги-

зарегистрированных векторов измерений. Пусть эти границы опреде-

определены, например, решающими функциями di(x), d2(\), ...

..., йм(х). Эти функции, называемые также дискриминантными

функциями, представляют собой скалярные и однозначные функ-

функции образа х. Если d*(x)>d/(x) для всех i, }= 1, 2, ..., М,

/ Ф i, то образ х принадлежит классу со,-. Другими словами, если

i-я решающая функция d,(x) имеет наибольшее значение, то

х е ю». Содержательной иллюстрацией подобной схемы автома-

автоматической классификации, основанной на реализации процесса

принятия решения, служит приведенная на рис. 1.5 блок-схема

(на схеме ГРФ означает «генератор решающих функций»).

Решающие функции можно получать целым рядом способов.

В тех случаях, когда о распознаваемых образах имеются полные

/ 3 Основные задачи, возникающие при разработке систем

25

априорные сведения, решающие функции могут быть определены

точно на основе этой информации. Если относительно образов

имеются лишь качественные сведения, могут быть выдвинуты

разумные допущения о виде решающих функций. В последнем

случае границы областей решений могут существенно откло-

отклоняться от истинных, и поэтому необходимо создавать систему,

способную приходить к удовлетворительному результату посред-

посредством ряда последовательных корректировок. Но, как правило,

ГРФ

Г РФ

-ч

ГРФ

dkW

ГРФ

ПРОЦЕСС

ПРИНЯТИЯ

РЕШЕНИЯ

хщ,

если djixl

Рис. 1.5. Блок-схема системы классификации образов.

мы обладаем лишь немногочисленными (если они вообще

имеются!) априорными сведениями о распознаваемых образах.

В этих условиях при построении распознающей системы лучше

всего использовать обучающую процедуру. На первом этапе

выбираются произвольные решающие функции и затем в про-

процессе выполнения итеративных шагов обучения эти решающие

функции доводятся до оптимального либо приемлемого вида.

Классификацию объектов с помощью решающих функций можно

осуществлять самыми различными способами. В данной книге

мы изучим несколько детерминистских и статистических алго-

алгоритмов нахождения решающих функций.

Решение задачи предварительной обработки и выделения

признаков и задачи получения оптимального решения и класси-

классификации обычно связано с необходимостью оценки и оптимиза-

оптимизации ряда параметров. Это приводит к задаче оценки параметров.

Кроме того, понятно, что и процесс выделения признаков, и

процесс принятия решений могут быть существенно усовершен-

усовершенствованы за счет использования информации, заключенной в

26 Гл. 1. Введете

контексте образов. Информация, содержащаяся в контексте,

может быть измерена с помощью условных вероятностей, линг-

лингвистических статистик и близких вариантов. В некоторых при-

приложениях просто необходимо использовать контекстуальную

информацию для точного распознавания. В частности, полная

автоматизация распознавания речи возможна только при нали-

наличии контекстуальной и лингвистической информации, дополняю-

дополняющей информацию, содержащуюся в записи звуковых сигналов

речи. По аналогичным причинам крайне желательно привлече-

привлечение контекстуальной информации при распознавании скорописи

и классификации отпечатков пальцев. Пытаясь построить рас-

распознающую систему, устойчивую по отношению к помехам, спо-

способную справиться с существенными отклонениями распозна-

распознаваемых объектов и обладающую способностью к самонастройке,

мы встречаемся с задачей адаптации.

Проведенное выше беглое обсуждение основных задач при-

приводит к помещенной на рис. 1.6 функциональной блок-схеме,

содержательно иллюстрирующей адаптивную систему распозна-

распознавания образов. Эта блок-схема показывает, как можно наибо-

наиболее естественно и разумно разделить функции, которые должна

выполнять распознающая система. Функциональные блоки вы-

выделены для удобства анализа, что отнюдь не означает их изо-

изоляцию и отсутствие межблочного взаимодействия. Хотя разли-

различия между получением оптимального решения и предваритель-

предварительной обработкой или выделением признаков несущественны, идея

функционального разделения создает четкую картину, поясняю-

поясняющую задачу распознавания образов.

Объекты (образы), подлежащие распознаванию и классифи-

классификации с помощью автоматической системы распознавания обра-

образов, должны обладать набором измеримых характеристик. Когда

для целой группы образов результаты соответствующих измере-

измерений оказываются аналогичными, считается, что эти объекты

принадлежат одному классу. Цель работы системы распознава-

распознавания образов заключается в том, чтобы на основе собранной

информации определить класс объектов с характеристиками,

аналогичными измеренным у распознаваемых объектов. Пра-

Правильность распознавания зависит от объема различающей ин-

информации, содержащейся в измеряемых характеристиках, и

эффективности использования этой информации. Если бы мы

были в состоянии измерить все возможные характеристики и

обладали неограниченным временем для обработки собранной

информации, то можно было бы достичь вполне адекватного

уровня распознавания, используя самые примитивные ме-

методы. В обычной практике, однако, ограничения по времени,

пространству и затратам требуют развития реалистических

подходов.

Объекты

ВОСПРИЯТИЕ

Результаты

измерении

АНАЛИЗ

С УЧЕТОМ

КОНТЕКСТА

ПРЕДВАРИТЕЛЬНАЯ

ОБРАБОТКА

И ВЫБОР

ПРИЗНАКОВ

Векторы признаков

или непрошбодные элементы

КЛАССИФИКАЦИЯ

Классы

образов

ОЦЕНКА,

АДАПТАЦИЯ,

ОБУЧЕНИЕ

Рис. 1.6. Функциональная блок-схема адаптивной системы распознавания образов.

28 Гл. 1. Введение

1.4. КРАТКОЕ ОПИСАНИЕ КОНЦЕПЦИЙ

И МЕТОДОЛОГИИ

В основе идеи синтеза систем автоматического

^ с помощью которых описываются и разде-

разделяются классы образов. Опираясь на наш опыт, мы предлагаем

рассмотреть несколько основных вариантов. Когда класс харак-

характеризуется перечнем входящих в него членов, построение си-

системы распознавания образов может быть основано на принципе

принадлежности к этому перечню. Когда класс характеризуется

некоторыми общими свойствами, присущими всем его членам,

построение системы распознавания может основываться на прин-

принципе общности свойств. Когда при рассмотрении класса обна-

обнаруживается тенденция к образованию кластеров в простран-

пространстве образов, построение системы распознавания может

основываться на принципе кластеризации1). Эти три основных

принципа построения систем распознавания образов обсуж-

обсуждаются ниже.

1. Принцип перечисления членов класса

Задание класса перечислением образов, входящих в его

состав, предполагает реализацию процесса автоматического

распознавания образов посредством сравнения с эталоном. Мно-

Множество образов, принадлежащих одному классу, запоминается

системой распознавания. При предъявлении системе незнакомых

(новых) образов она последовательно сравнивает их с храня-

хранящимися в ее памяти. Система распознавания образов относит

новый образ к тому классу, к которому принадлежал находя-

находящийся в памяти системы образ, совпавший с новым. Так, напри-

например, если в память системы распознавания введены литеры

различных наборных шрифтов, то подход, основанный на пере-

перечислении членов класса, позволяет распознавать соответствую-

соответствующие буквы, но только в тех случаях, когда их изображения не

искажены шумом, связанным с размазыванием или плохим на-

нанесением краски, пористостью бумаги и т. п. Несомненно, это

') Под кластером понимают обычно группу объектов (образов), обра-

образующих в пространстве описания компактную в некотором смысле область.

Понятие «кластеризация» стало использоваться в последнее время незави-

независимо от понятия «таксономия», хотя и тот, и другой методы разбиения осно-

основаны на принципе геометрической «близости» объектов на данном иерархи-

иерархическом уровне рассмотрения, и понятия «кластер» и «таксон» в сущности

идентичны. Более подробные сведения по поводу особенностей этой группы

методов распознавания можно найти в монографиях Н. Г. Загоруйко «Ме-

«Методы распознавания и их применение», «Советское Радио», М, 1972, и Б. Дю-

рана и П. Оделла «Кластерный анализ», «Статистика», М., 1977. — Прим.

перев.

1.4. Краткое описание концепций и методологии 29

несложный метод, однако он позволяет строить недорогие си-

системы распознавания, которые в отдельных прикладных обла-

областях вполне справляются со своими задачами. Метод перечис-

перечисления членов класса работает удовлетворительно, если выборка

образов близка к идеальной ').

2. Принцип общности свойств

Задание класса с помощью свойств, общих для всех входя-

входящих в его состав членов, предусматривает реализацию процесса

автоматического распознавания путем выделения подобных при-

признаков и работы с ними. Основное допущение в этом методе

заключается в том, что образы, принадлежащие одному и тому

же классу, обладают рядом общих свойств или признаков, отра-

отражающих подобие таких образов. Эти общие свойства можно,

в частности, ввести в память системы распознавания. Когда

системе предъявляется неклассифицированный образ, то выде-

выделяется набор описывающих его признаков, причем последние

иногда кодируются, и затем они сравниваются с признаками,

заложенными в память системы распознавания. В таком случае

последняя зачислит предъявленный для распознавания образ в

класс, характеризующийся системой признаков, подобных при-

признакам этого образа. Итак, при использовании данного метода

основная задача заключается в выделении ряда общих свойств

по конечной выборке образов, принадлежность которых иско-

искомому классу известна.

Очевидно, что эта концепция распознавания во многих отно-

отношениях превосходит распознавание по принципу перечисления

членов класса. Для запоминания признаков класса требуется

значительно меньше памяти, чем для хранения всех объектов,

входящих в класс. Поскольку признаки, характеризующие класс

Bjjejjpjvi, обладают инвариантностью, ^^^цип^сшюст^вления^

ПЕИзнак?в_до_пускает_^адиайи1о^„х^д^гщщс^и"к^ отд^л ьн ы Xjo6p_a -

зов...Процедура сопоставления с эталоном, с другой стороны, не

допускает существенных вариаций характеристик отдельных

') Авторы имеют в виду, что идея пириципа перечисления элементов клас-

класса достаточно проста. В тех случаях, когда классы состоят из большого чис-

числа элементов и каждый элемент описывается значениями большого числа

признаков, реализация этого принципа является весьма нетривиальной и при-

приводит к необходимости решать трудные математические задачи. Существуют

специальные разделы прикладной математики, исследующие такие задачи.

В качестве примера можно указать на теорию тестов (И. А. Чегис, С. В. Яб-

Яблонский, Логические способы контроля электрических схем, Труды Мат. ин-та

им. В. А. Стеклова, 51, 1958), активно применяемую в последние годы к ре-

решению задач распознавания. Обзор таких применений можно найти в статье

Ю. И. Журавлева «Непараметрнческне задачи распознавания образов» (Ки-

(Кибернетика, № 6, 1976 г.). —Прим. ред.

30 Гл. 1 Введение

образов. Если все признаки, определяющие класс, можно найти

по имеющейся выборке ^образов, то процесс распознавания сво-

сводится просто к сопоставлению по признакам. Исключительно

трудно, однако, если не невозможно вообще, как уже упоми-

упоминалось выше, найти для некоторого класса полный набор раз-

различающих признаков. Следовательно, обращение к этому прин-

принципу распознавания часто связано с необходимостью развития

методов выбора признаков, являющихся в некотором смысле

оптимальными. В гл. 7 рассмотрено несколько методов выбора

признаков. Кроме того, как мы убедимся ниже, принцип общ-

общности свойств лежит в основе процессов распознавания, реали-

реализуемых методами теории формальных языков.

3. Принцип кластеризации

Когда образы некоторого класса представляют собой век-

векторы, компонентами которых являются действительные числа,

этот класс можно рассматривать как кластер и выделять только

его свойства в пространстве образов кластера. Построение си-

систем распознавания, основанных на реализации данного прин-

принципа, определяется взаимным пространственным расположением

отдельных кластеров. Если кластеры, соответствующие различ-

различным классам, разнесены достаточно далеко друг от друга, то с

успехом можно воспользоваться сравнительно простыми схе-

схемами распознавания, например такими, как классификация по

принципу минимального расстояния, рассмотренная в гл. 3.

Если же кластеры перекрываются, приходится обращаться к

более сложным методам разбиения пространства образов, по-

подобно, например, рассмотренным в гл. 4—6. Перекрытие класте-

кластеров является результатом неполноценности доступной информа-

информации и шумовых искажений результатов измерения. Поэтому

степень перекрытия часто удается уменьшить, увеличивая коли-

количество и качество измерений, выполняемых над образами не-

некоторого класса.

.Для реализации рассмотренных выше основных принципов

построения автоматических систем распознавания образов суще-

существуют три основных типа методологии: эвристическая, матема-

математическая и лингвистическая (синтаксическая). Нередко системы

распознавания создаются на основе комбинации этих методов.

1. Эвристические методы

За основу эвристического подхода взяты интуиция и опыт

человека; в нем используются принципы перечисления членов

класса и общности свойств. Обычно системы, построенные та-

1.4. Краткое описание концепций и методологии 31

ними методами, включают набор специфических процедур, раз-

разработанных применительно к конкретным задачам распознава-

распознавания. В § 1.2 приведен пример подобного подхода в связи с

задачей распознавания символов, в которой классификация

образа (символа) производилась на основе выделения опреде-

определенных признаков, в частности таких, как количество и после-

последовательность расположения специфических штрихов (черто-

(черточек). Хотя эвристический подход играет большую роль в по-

построении систем распознавания образов, не много может быть

скаэа-но относительно общих принципов синтеза, так как реше-

решение, каждой конкретной задачи требует использования специфи-

специфических приемов разработки системы. Это означает, следова-

следовательно, что структура и качество эвристической системы в зна-

значительной степени определяются одаренностью и опытом

разработчиков.

2. Математические методы

" В основу математического подхода положены правила клас-

классификации, которые формулируются и выводятся в рамках опре-

определенного математического формализма с помощью принципов

общности свойств и кластеризации. Этим данный подход отли-

отличается от эвристического, в котором решения определяются с

помощью правил, тесно связанных с характером решаемой за-

задачи. Математические методы построения систем распознавания

можно разделить на два класса: детерминистские и статисти-

статистические.

"Детерминистский подход базируется на математическом ап-

аппарате, не использующем в явном виде статистические свойства

изучаемых классов образов. Примером детерминистского под-

подхода могут служить рассматриваемые в гл. 5 итеративные алго-

алгоритмы обучения.

Статистический подход основывается на математических пра-

правилах классификации, которые формулируются и выводятся в

терминах математической статистики. Как мы увидим ниже

в гл. 4 и 6, построение статистического классиф^укатода^Т^д^

сАу«1ае_ предполагает использование баиесова5о_го__классифика-

ционного правила и его разновидностейГНтсГправило'оо'ёспечи-

вает получение оптимального классйГфйкатора в тех случаях,

когда известны плотности распределения для всех совокупностей

образов и вероятности появления образов для каждого класса.

3. Лингвистические (синтаксические) методы

Если описание образов производится с помощью непроиз-

непроизводных элементов (подобразов) и их отношений, то для по-

построения автоматических систем распознавания применяется

32 Гл. I. Введение

лингвистический или синтаксический подход с использованием

принципа общности свойств. Образ можно описать с помощью

иерархической структуры подобразов, аналогичной синтаксиче-

синтаксической структуре языка. Это обстоятельство позволяет применять

при решении задач распознавания образов теорию формальных

языков. Предполагается, что грамматика образов содержит ко-

конечные множества элементов, называемых переменными, непро-

непроизводными элементами и правилами подстановки. Характер пра-

правил подстановки определяет тип грамматики. Среди наиболее

изученных грамматик можно отметить регулярные, бесконтекст-

бесконтекстные и грамматики непосредственно составляющих. Ключевыми

моментами данного подхода являются выбор непроизводных

элементов образа, объединение этих элементов и связывающих

их отношении в грамматики образов и, наконец, реализация в

соответствующем языке процессов анализа и распознавания.

Такой подход (он обсуждается в гл. 8) особенно полезен при

работе с образами, которые либо не могут быть описаны число-

числовыми измерениями, либо столь сложны, что их локальные при-

признаки идентифицировать не удается и приходится обращаться к

глобальным свойствам объектов.

В нашей книге основное внимание будет уделено второму

и третьему подходам. Хотя, как отмечалось выше, эвристический

подход весьма важен, в целом о нем можно сказать очень не-

немного1). Следует, однако, заметить, что глубокое понимание

других методов является прочной гарантией построения систем

распознавания на основании интуитивного подхода.

Выбор метода синтеза системы еще не решает до конца проб-

проблему составления конкретной программы и проблемы реализа-

реализации. В большинстве случаев у нас в распоряжении имеются

репрезентативные образы, представляющие каждый из рассмат-

рассматриваемых классов. В таких ситуациях можно воспользоваться

методами распознавания, называющимися обучением с учите-

учителем. В схеме обучения с учителем система «обучается» распозна-

распознавать образы с помощью разного рода адаптивных схем. Клю-

Ключевыми элементами такого подхода являются обучающие мно-

') После выхода в свет монографии Ту и Гонсалеса появились работы,

в которых исследовались модели эвристических алгоритмов. Оказалось, что

эвристические методы принципиально мало отличаются от методов, которые

авторы называют математическими. Оказалось также, что если модели эври-

эвристических алгоритмов удовлетворяют простым, сравнительно несложно про-

проверяемым условиям, то нетрудно построить специальную алгебру над такими

алгоритмами. Элементы этой алгебры сами являются алгоритмами, и, кроме

того, оперируя с алгоритмами из алгебры, можно не только доказать теоремы

существования безошибочных алгоритмов распознавания, но и получить яв-

явные формулы для реализации таких алгоритмов (Ю. И. Журавлев, Коррект-

Корректные алгебры над множествами некорректных (эвристических) алгоритмов I,

И, III, Кибернетика, № 4, 6, 1977, № 2, 1978). — Прим.. ред.

IS. Примеры автоматических систем распознавания образов 33

жества образов, классификация которых известна, и реализация

соответствующей процедуры обучения.

В некоторых прикладных задачах принадлежность к опреде-

определенным классам элементов обучающего множества неизвестна.

В таких случаях можно обратиться к методам распознавания

образов, называющимся распознаванием без учителя. Как ука-

указывалось ранее, распознавание по схеме «обучение с учителем»

характеризуется тем, что известна правильная классификация

каждого обучающего образа. В случае «обучения без учителя»

требуется, однако, конкретно изучить классы образов, которые

имеются в данной информации. Эта задача довольно подробно

рассматривается в гл. :3.

Важно ясно представлять себе, что обучение происходит

только на этапе построения (или коррекции в связи с поступле-

поступлением новой информации) системы распознавания. Как только

система, работая с обучающим множеством образов, добивается

приемлемых результатов, ей предлагается реальная задача рас-

распознавания пробных объектов, взятых из той среды, в которой

системе предстоит работать. Естественно, качество распознава-

распознавания будет в существенной степени определяться тем, насколько

хорошо обучающие образы представляют реальные данные, с

которыми система будет сталкиваться в процессе нормальной

эксплуатации.

1.5. ПРИМЕРЫ АВТОМАТИЧЕСКИХ СИСТЕМ

РАСПОЗНАВАНИЯ ОБРАЗОВ

В последнее десятилетие возник значительный интерес к

исследованию и построению систем автоматического распозна-

распознавания образов и машинного обучения. Мы стали свидетелями

быстрого прогресса в этой области. Примеры автоматических

систем распознавания образов имеются в изобилии. Были пред-

предприняты успешные попытки создавать устройства и программы

чтения наборных и напечатанных на машинке символов, обра-

обработки электрокардиограмм и. электроэнцеф_ал.ограм_м, распозна-

распознавания^ произнесенных слов, идентификации отпечатков пальцев

и интерпретации фотоснимков. В качестве других приложений

можно указать распознавание символов и слов, написанных от

руки, постановку медицинского диагноза, классификацию сейсми-

сейсмических волн, обнаружение объектов противника, прогноз погоды,

идентификацию отказов и неисправностей отдельных механиз-

механизмов и целых производственных процессов. В данном параграфе

рассмотрим несколько иллюстративных примеров, относящихся

к тем областям, в которых принципы распознавания образов

нашли удачное применение.

2 За к. 594

34

Гл. I. Введение

Распознавание символов

Примером практического использования автоматической

классификации образов являются оптические устройства распо-

распознавания символов, в частности машины для считывания кодо-

кодовых символов с обычных банковских чеков. На большинстве

J

A

4

I

/

\

\

\

1

4i

IV

1*

/

L

V

т

\

\

г

i

1

1

U

у

i

\

1

\

f

I

\

1

\

\

\

\

j

1

\

1

/L,

Д

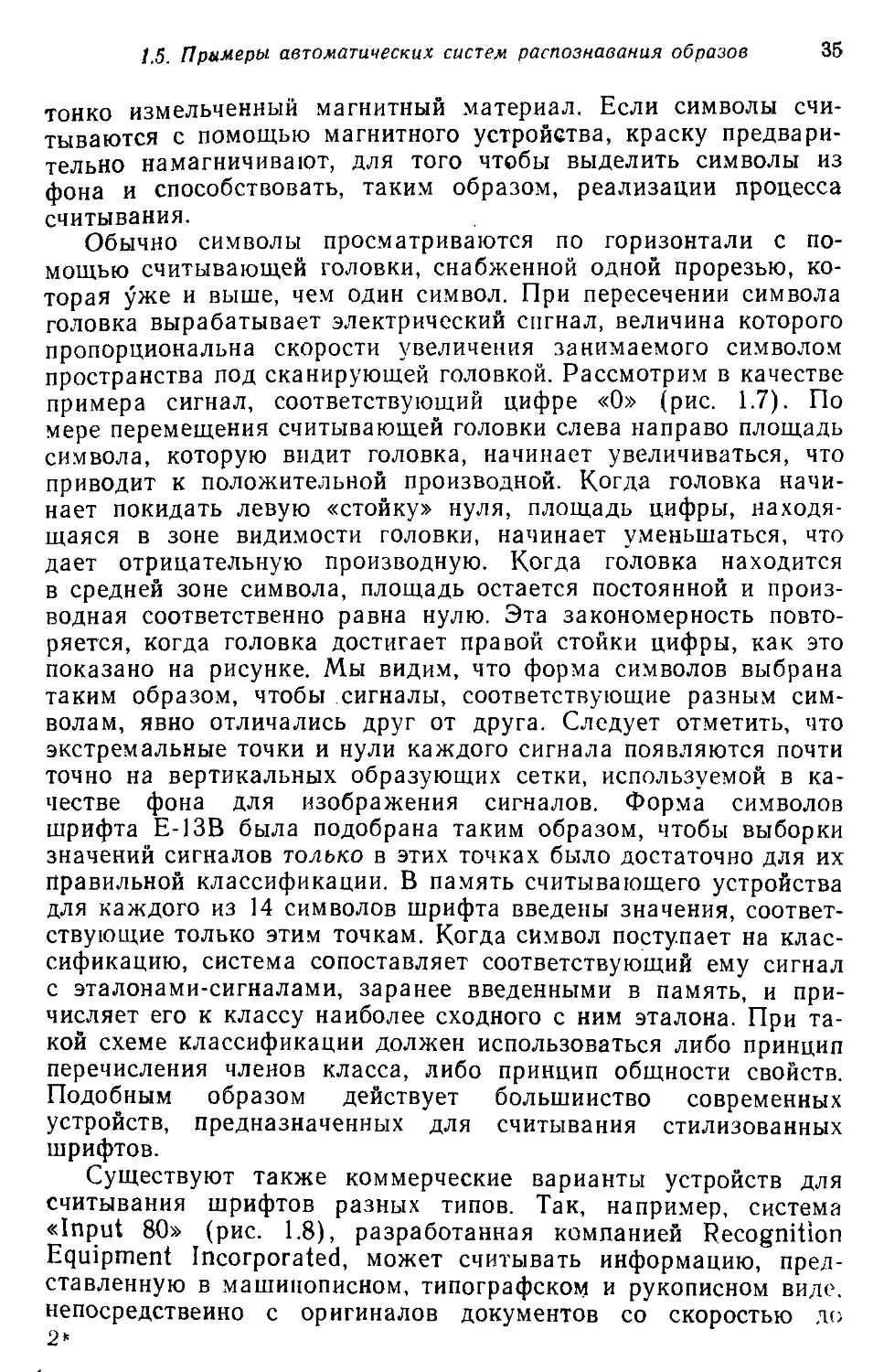

Рис. 1.7. Комплект шрифта Е-13В Американской банковской ассоаиации (Ame-

(American Bankers Association) и формы сигнала, соответствующие отдельным

символам набора.

чеков, имеющих хождение в настоящее время в Соединенных

Штатах, в качестве стилизованных символов используется стан-

стандартный комплект шрифта Е-13В Американской банковской ас-

ассоциации (American Bankers Association). Как следует из

рис. 1.7, этот комплект включает 14 символов, специально адап-

адаптированных к сетчатке, содержащей 9X7 участков, с тем что-

чтобы упростить процесс считывания. Эти символы обычно нано-

наносятся особой типографской краской, которая содержит очень

1.5. Примеры автоматических систем распознавания образов 35

тонко измельченный магнитный материал. Если символы счи-

тываются с помощью магнитного устройства, краску предвари-

предварительно намагничивают, для того чтобы выделить символы из

фона и способствовать, таким образом, реализации процесса

считывания.

Обычно символы просматриваются по горизонтали с по-

помощью считывающей головки, снабженной одной прорезью, ко-

которая уже и выше, чем один символ. При пересечении символа

головка вырабатывает электрический сигнал, величина которого

пропорциональна скорости увеличения занимаемого символом

пространства под сканирующей головкой. Рассмотрим в качестве

примера сигнал, соответствующий цифре «О» (рис. 1.7). По

мере перемещения считывающей головки слева направо площадь

символа, которую видит головка, начинает увеличиваться, что

приводит к положительной производной. Когда головка начи-

начинает покидать левую «стойку» нуля, площадь цифры, находя-

находящаяся в зоне видимости головки, начинает уменьшаться, что

дает отрицательную производную. Когда головка находится

в средней зоне символа, площадь остается постоянной и произ-

производная соответственно равна нулю. Эта закономерность повто-

повторяется, когда головка достигает правой стойки цифры, как это

показано на рисунке. Мы видим, что форма символов выбрана

таким образом, чтобы сигналы, соответствующие разным сим-

символам, явно отличались друг от друга. Следует отметить, что

экстремальные точки и нули каждого сигнала появляются почти

точно на вертикальных образующих сетки, используемой в ка-

качестве фона для изображения сигналов. Форма символов

шрифта Е-13В была подобрана таким образом, чтобы выборки

значений сигналов только в этих точках было достаточно для их

правильной классификации. В память считывающего устройства

для каждого из 14 символов шрифта введены значения, соответ-

соответствующие только этим точкам. Когда символ поступает на клас-

классификацию, система сопоставляет соответствующий ему сигнал

с эталонами-сигналами, заранее введенными в память, и при-

причисляет его к классу наиболее сходного с ним эталона. При та-

такой схеме классификации должен использоваться либо принцип

перечисления членов класса, либо принцип общности свойств.

Подобным образом действует большинство современных

устройств, предназначенных для считывания стилизованных

шрифтов.

Существуют также коммерческие варианты устройств для

считывания шрифтов разных типов. Так, например, система

«Input 80» (рис. 1.8), разработанная компанией Recognition

Equipment Incorporated, может считывать информацию, пред-

представленную в машинописном, типографском и рукописном виде.

непосредственно с оригиналов документов со скоростью до

2

36

Гл. 1. Введение

3600 символов в секунду. Словарь системы построен по модуль-

модульному принципу, и его можно перестраивать, исходя из требова-

требований конкретной прикладной задачи. Одношрифтовая система

способна считывать символы одного из множества известных

комплектов шрифта, а многошрифтовая система позволяет ра-

работать «одновременно» с рядом типов шрифта, выбранных поль-

пользователем из множества допустимых. Одно устройство может

Рис. 1.8. Система распознавания символов «REI Input 80 Model А» компании

Recognition Equipment Incorporated, Даллас, штат Техас. На рисунке пред-

представлены следующие компоненты системы (по часовой стрелке): блок рас-

распознавания, контроллер с программным управлением, печатающее устройство

для ввода/вывода данных, построчно-печатающее устройство, блок распозна-

распознавания, блок магнитной ленты и страничный процессор. Фотография любезно

предоставлена Recognition Equipment Incorporated.

распознавать вплоть до 360 различных символов. Система может

быть настроена и таким образом, чтобы она считывала машино-

машинописные числа, отбирала машинописные буквы и символы и счи-

считывала данные, напечатанные типографским способом.

Основные особенности работы системы «Input 80» REI за-

заключаются в следующем. Страницы с помощью системы разре-

разреженных участков и воздушных эжекторов попадают на ленточ-

ленточный конвейер, который подает их в считывающее устройство.

Здесь зеркальце, совершающее высокочастотные колебания,

фокусирует луч света высокой интенсивности на символах, под-

подлежащих считыванию; луч пересекает строку печатных симво-

символов со скоростью около 7,62 м/с. Второе, синхронизирующее,

зеркальце воспринимает световые изображения, представляю-

15. Примеры автоматических систем распознавания образов 37

щие различные части символа, и проектирует их на «инте-

«интегральную ретину» — считывающее устройство, выполненное на

.интегральной схеме; оно состоит из 96 фотодиодов, размещен-

размещенных в одной кремниевой пластине длиной около 38,1 мм. Это

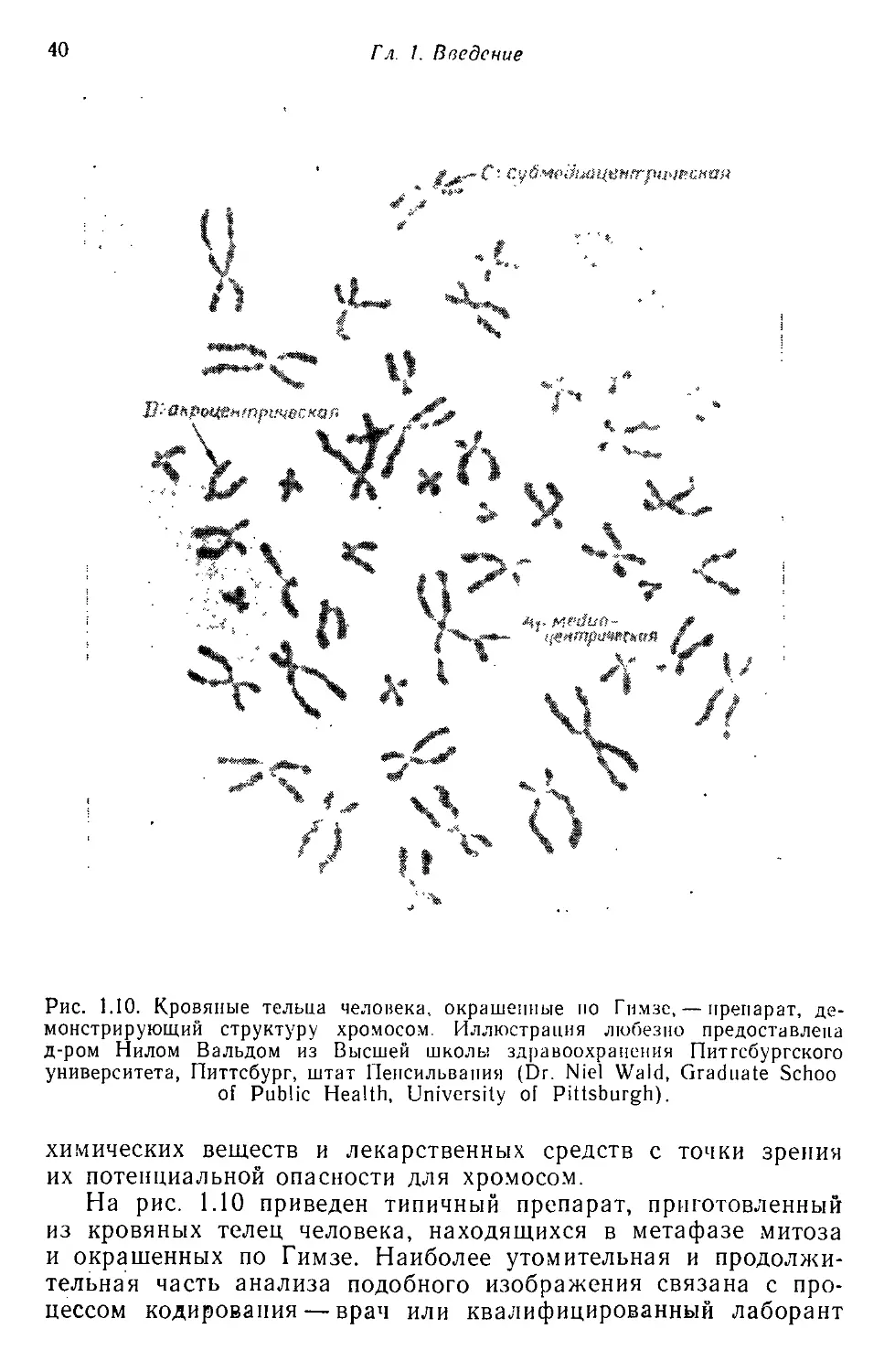

устройство является «глазом» системы. Интегральная ретина