Автор: Поляк Б.Т.

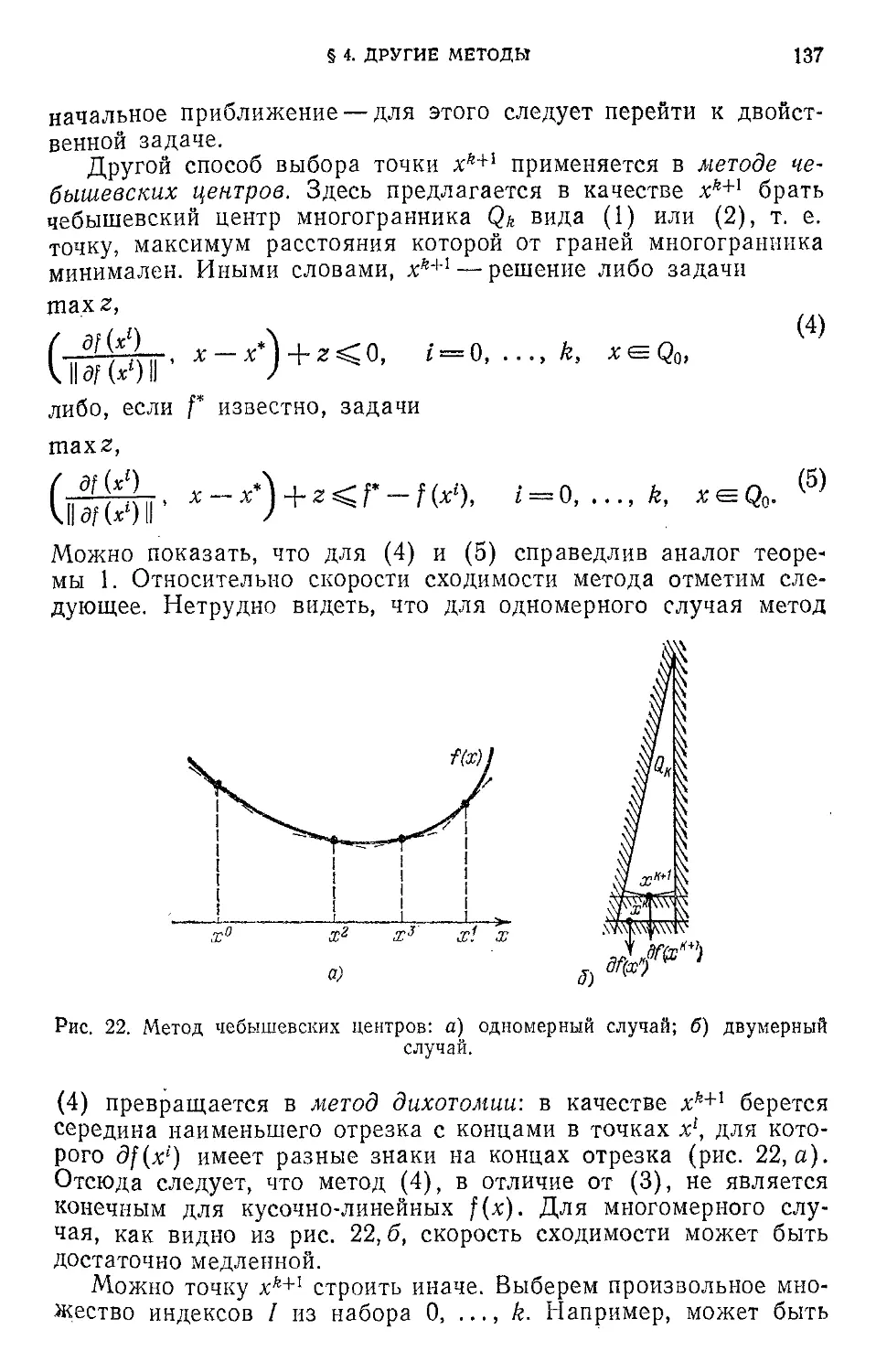

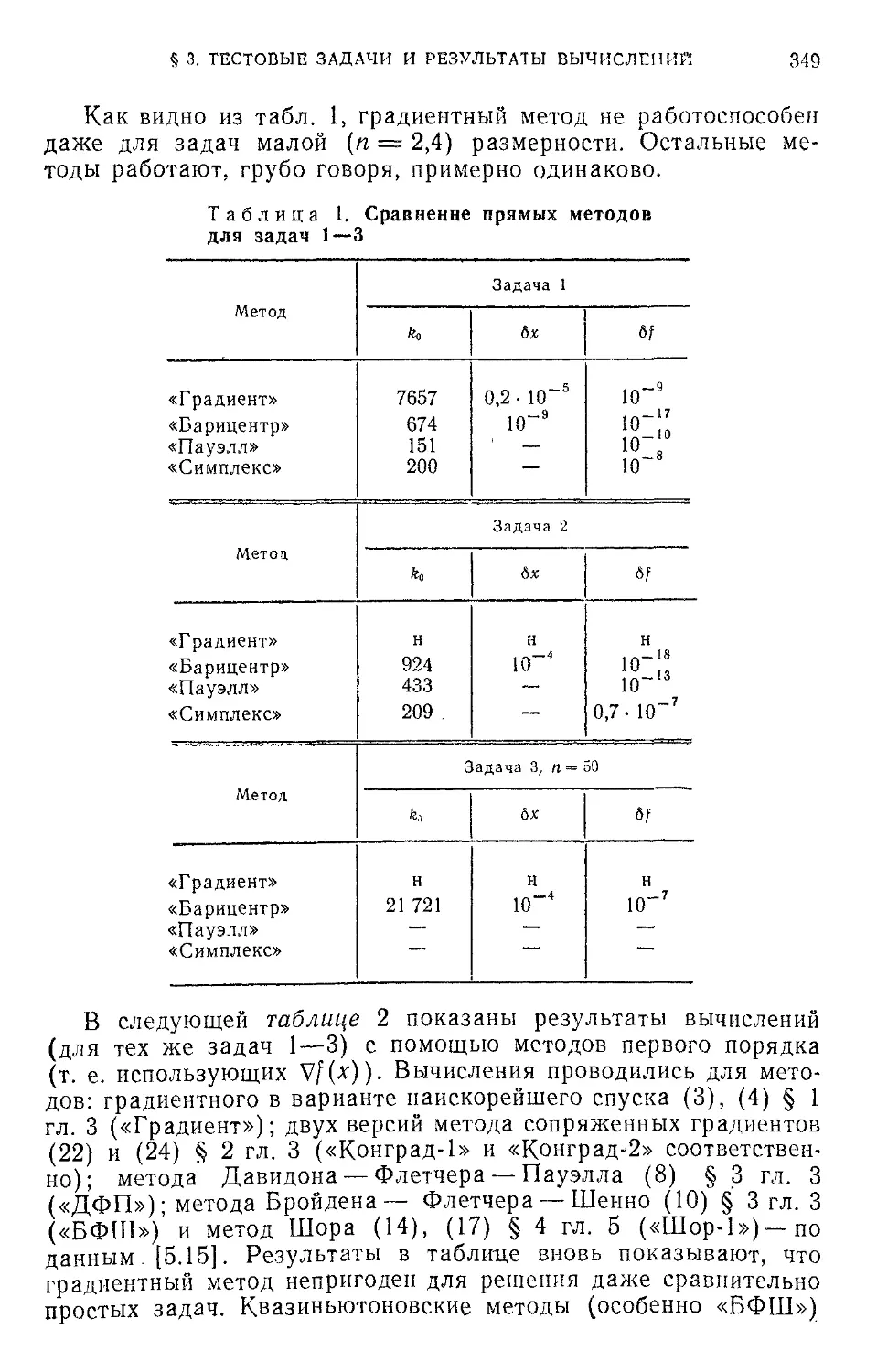

Теги: регулирование и управление машинами, процессами инженерия регулирование и управление машинами

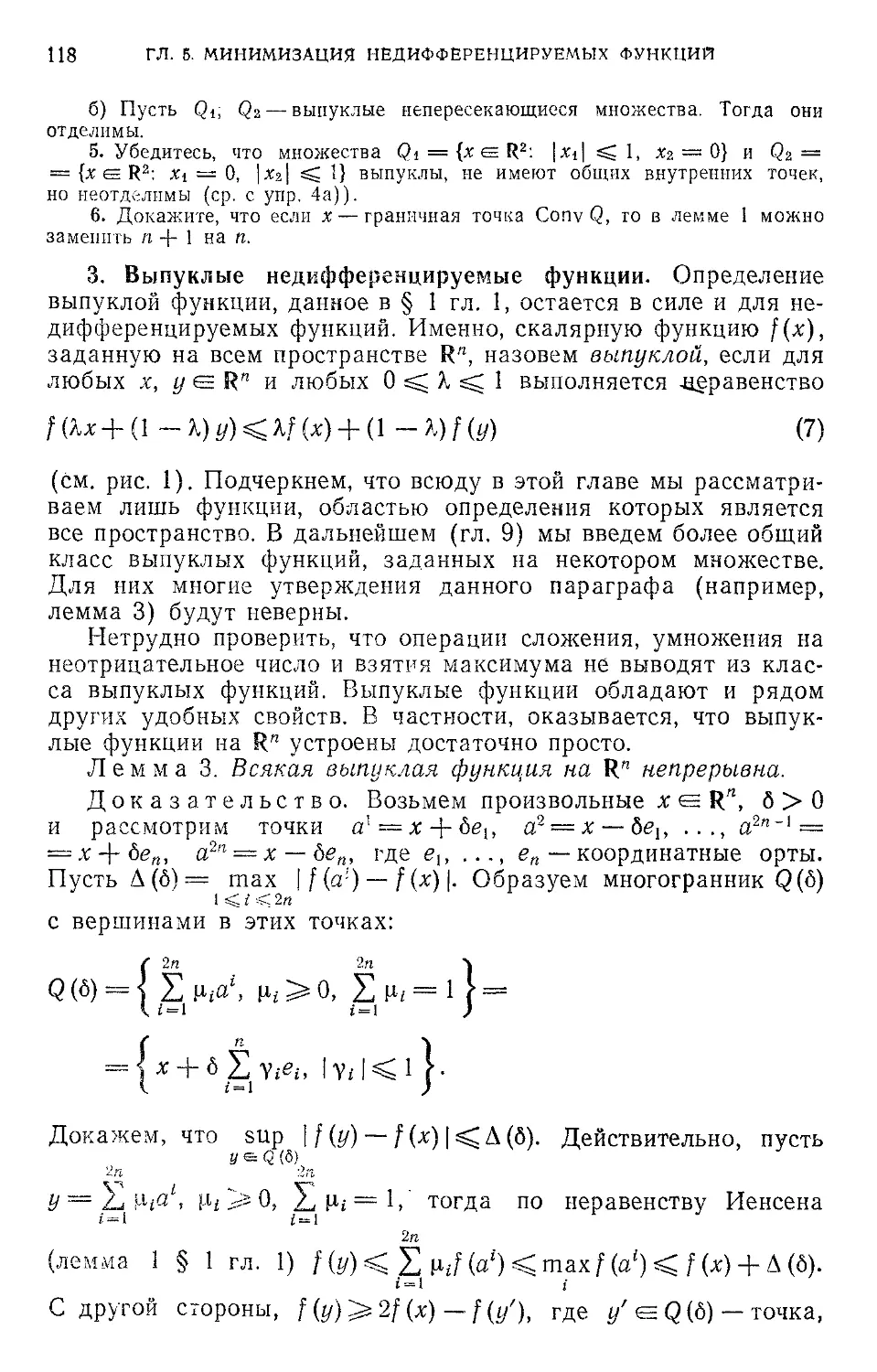

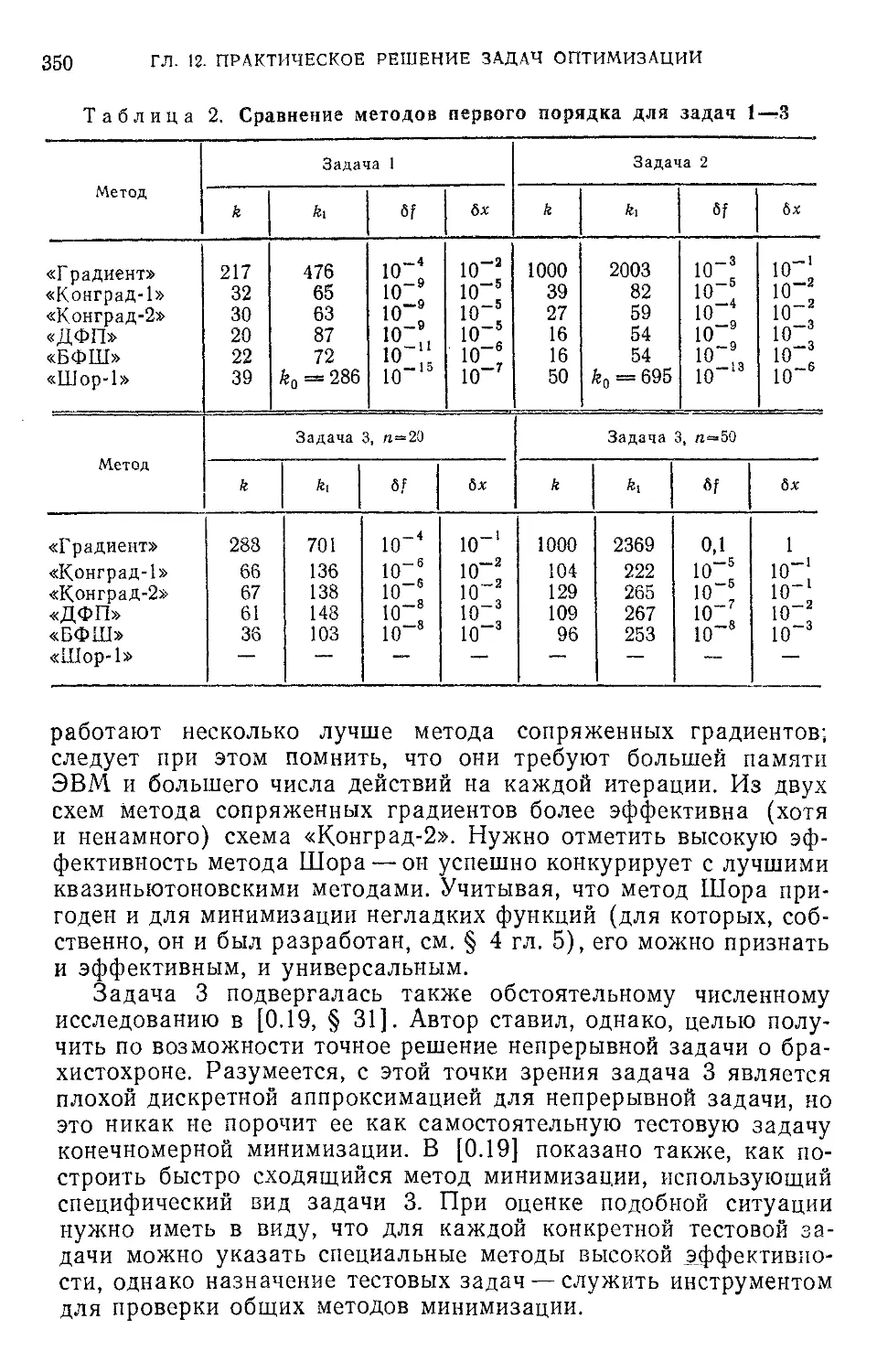

Год: 1983

Текст

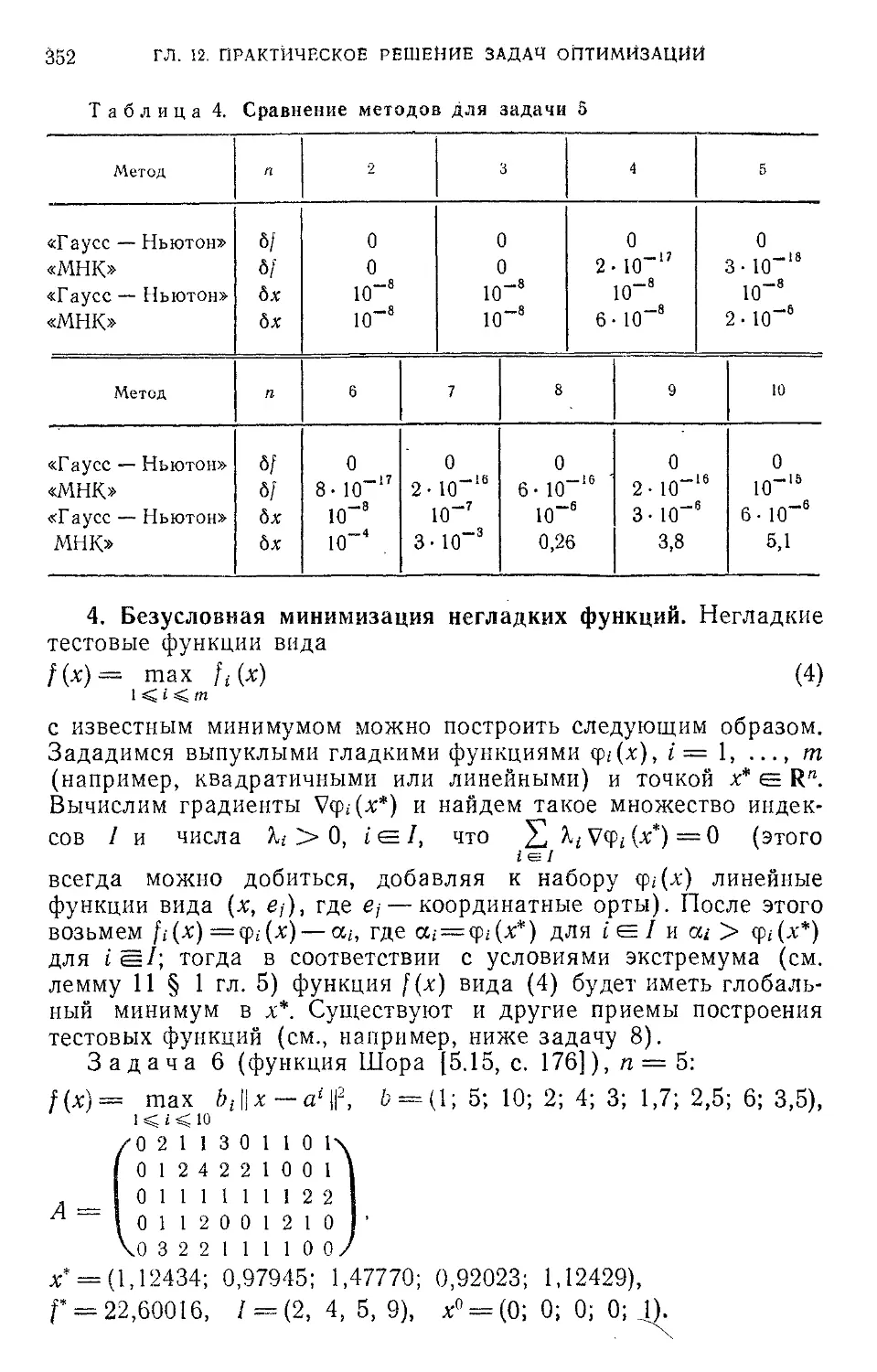

32.81

П 64

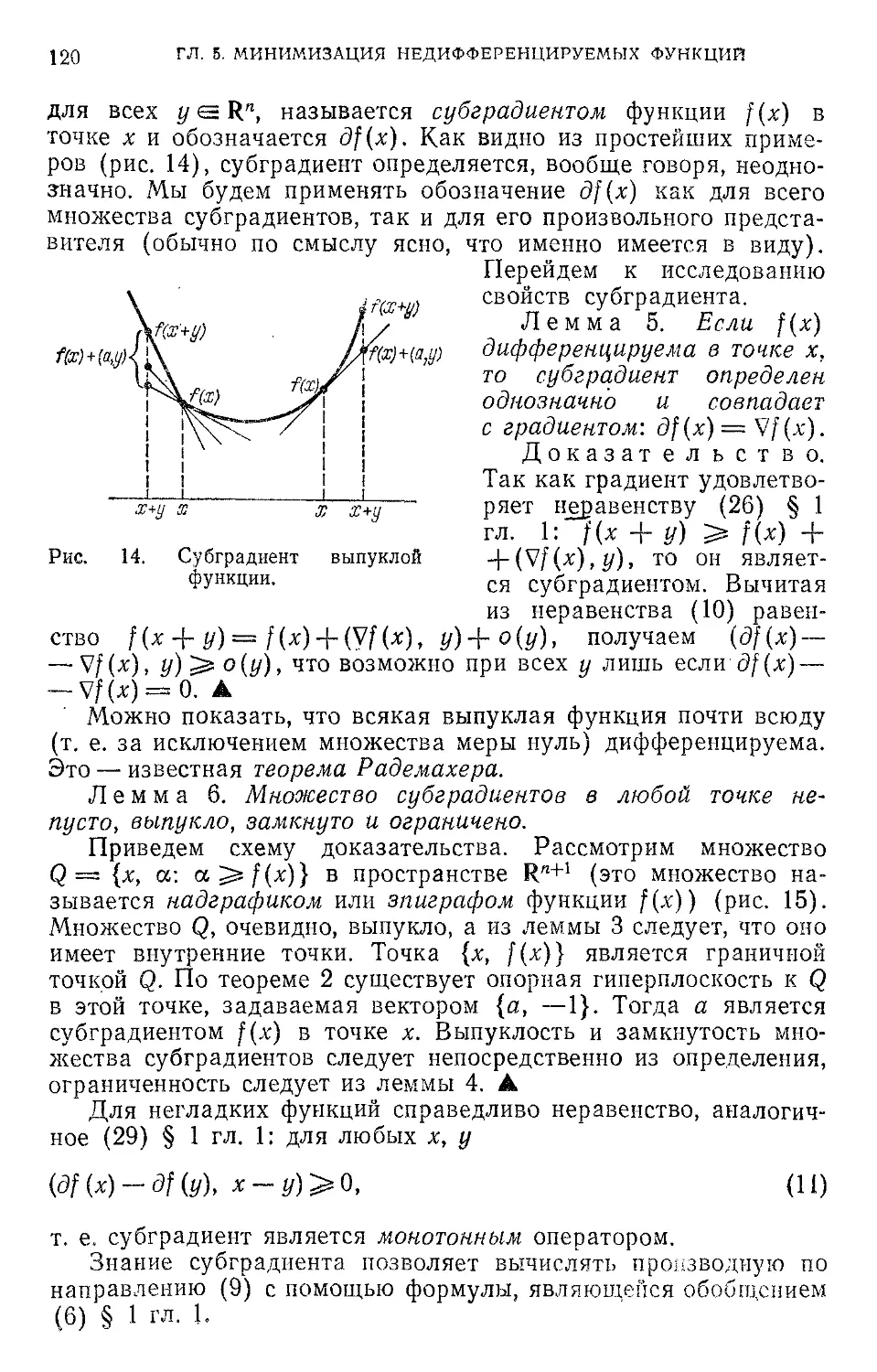

УДК 62-50

Введение в оптимизацию. Поляк Б. Т.— М.: Наука. Главная редак-

ция физико-математической литературы, 1983.—384 с.

Книга является систематическим введением в современную теорию

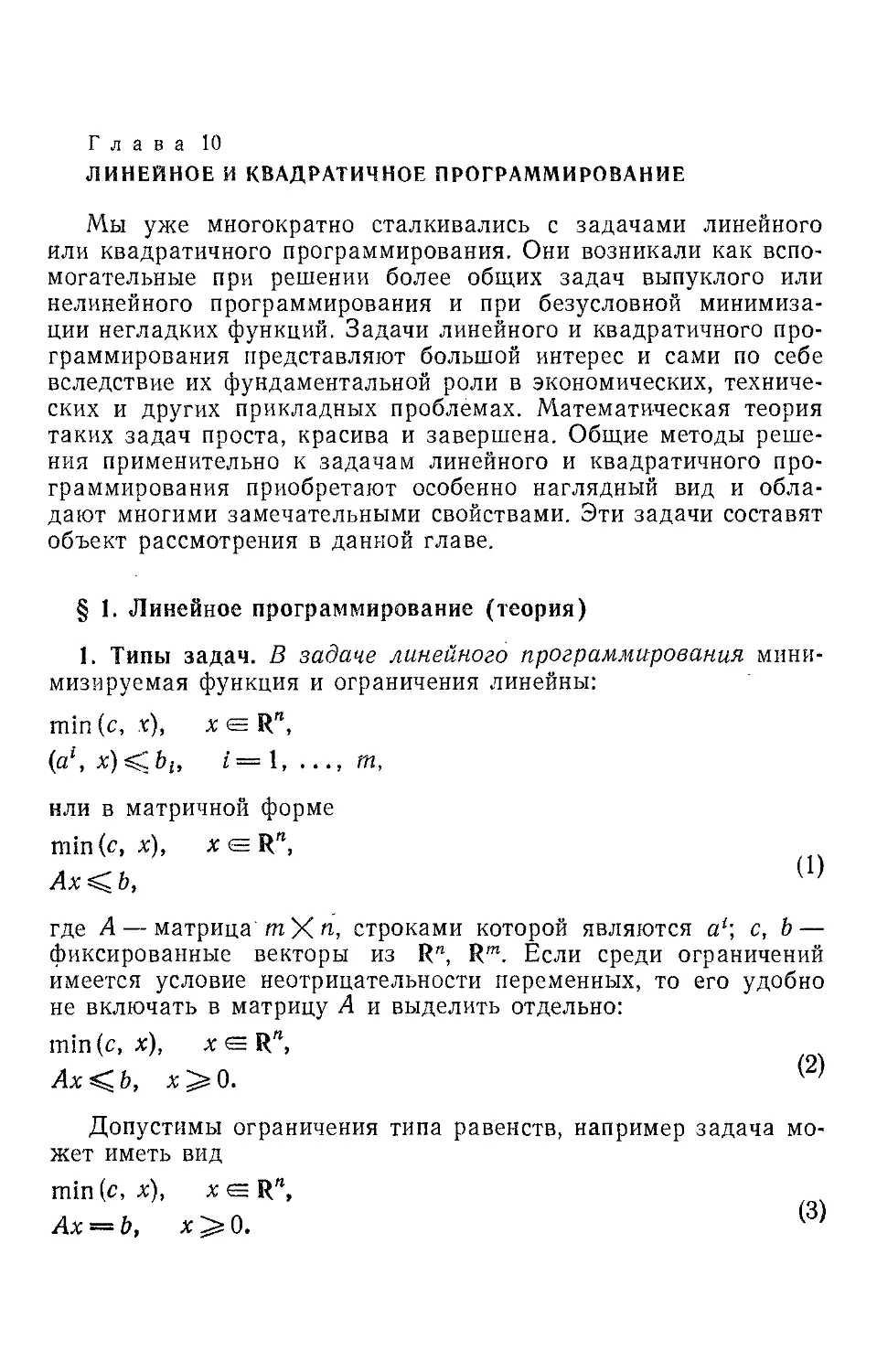

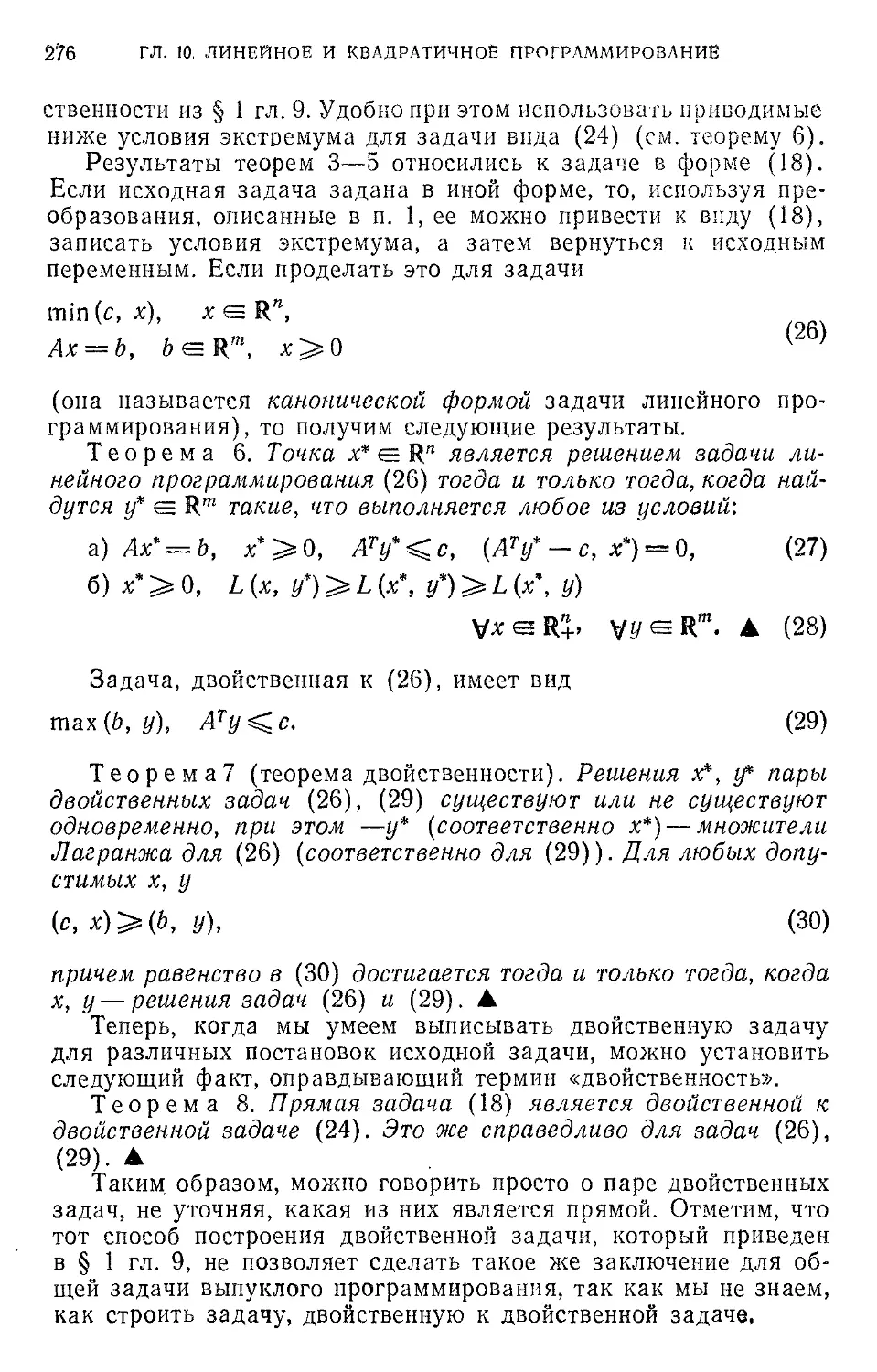

и методы оптимизации для конечномерных задач. Основное внимание уделя-

ется идейным осиовагл методов, их сравнительному анализу и примерам

использования. Охвачен широкий круг задач — от линейного программирова-

ния и безусловной минимизации до стохастического программирования. Об-

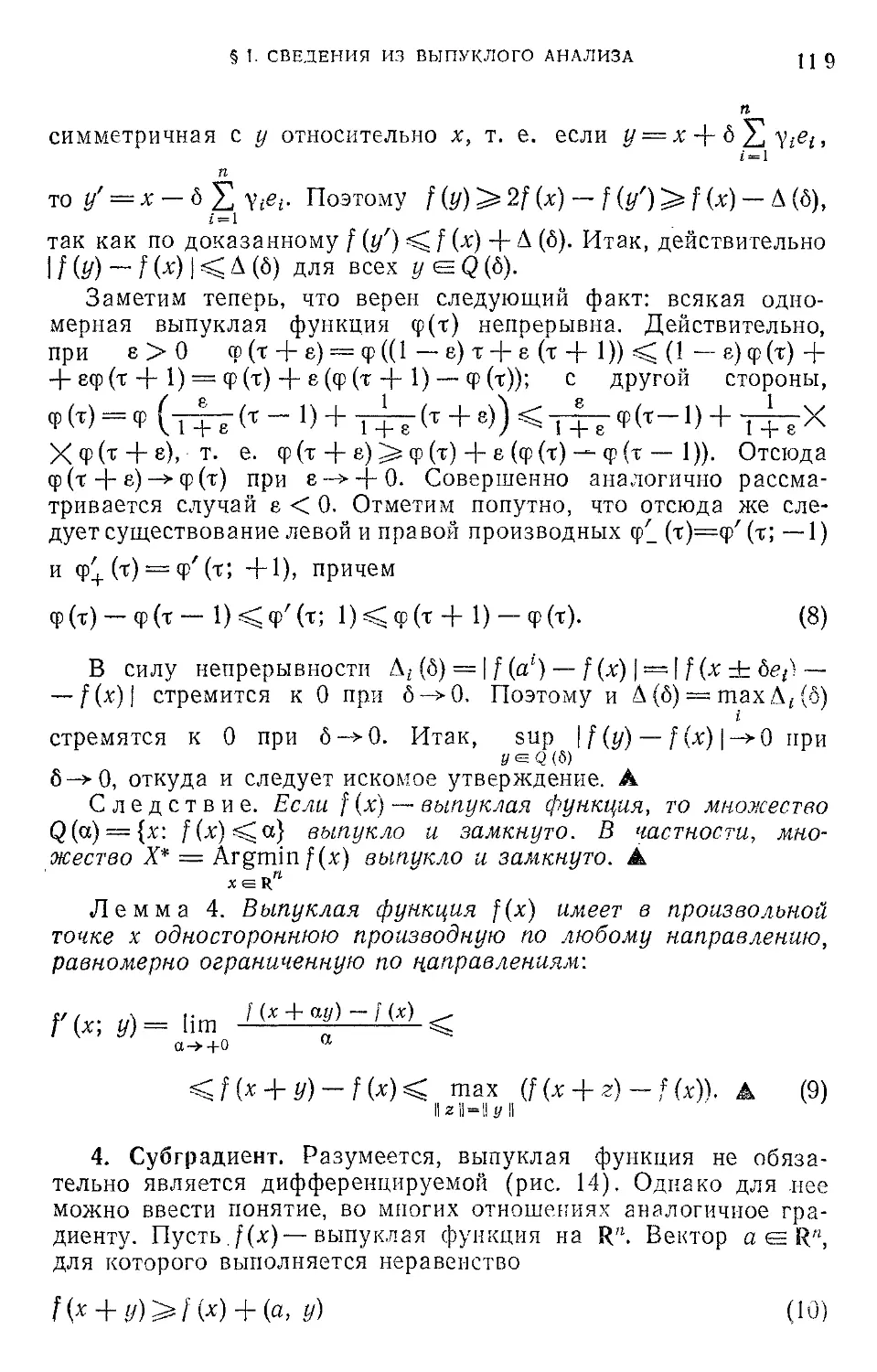

суждается методика постановки и решения прикладных проблем оптимиза-

ции. Приводятся условия экстремума, теоремы существования, единственности

и устойчивости решения для основных классов задач. Исследуется влияние

помех, негладкости функций, вырожденности минимума. Книга предназначена

для инженеров, экономистов, статистиков, вычислителей, сталкивающихся

с задачами оптимизации. По своему математическому аппарату книга доступ-

на студентам технических и экономических вузов.

Табл. 6, илл. 44, библ. 247.

Борис Теодорович Поляк

ВВЕДЕНИЕ В ОПТИМИЗАЦИЮ

Редактор Т. И. Кузнецова

Технический редактор В. Н. Кондакова

Корректоры О. А. Сигал, Л. С. Сомова

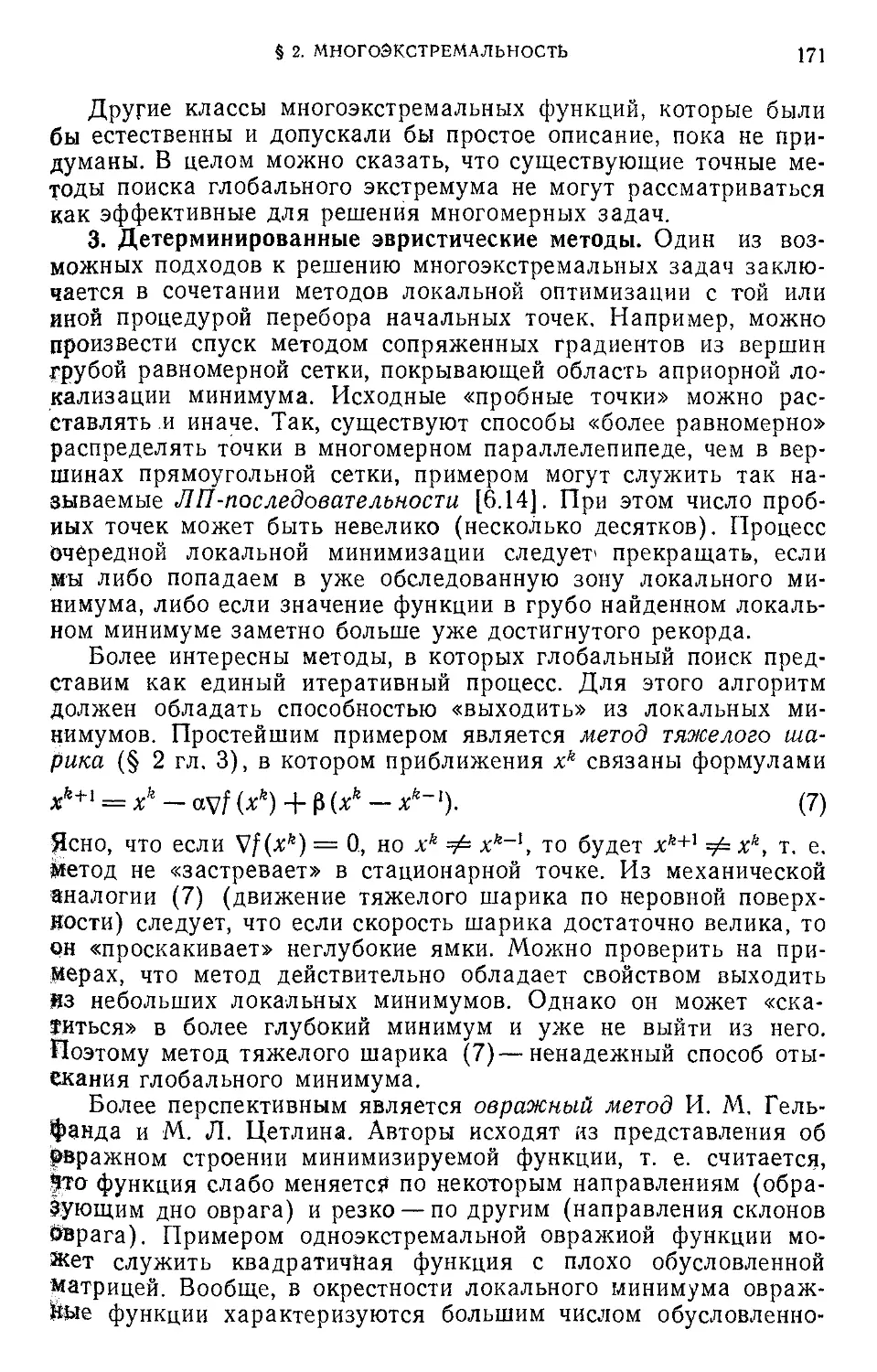

ИВ № 11436

Сдано в набор 22.04.82. Подписано к печати 06.04.83. Т-08902. Формат 60х907ю. Вумага

№ 2. Литературная гарнитура. Высокая печать. Условн. печ. л. 24. Уч.-изд. л. 26,32.

Тираж 8500 экз. Заказ № 179. Цена 2 р. 40 к.

Издательство «Наука»

Главная редакция физико-математической литературы

117071, Москва, В-71, Ленинский проспект, 15

Ленинградская типография A's 2 головное предприятие ордена Трудового Красного

Знамени Ленинградского объединения «Техническая книга» им. Евгении Соколовой Союз-

иолиграфпрома при Государственном комитете СССР по делам издательств, полиграфии

и книжной торговли. 198052, г. Ленинград, Л-52, Измайловский проспект, 29

1502000000—074

П 053(02)-83

153-82

© Издательство «Наука».

Главная редакция

физико-математической литературы,

1983

ОГЛАВЛЕНИЕ

Предисловие........................................................ 5

Список обозначений ................................................ 7

Введение .......................................................... 9

ЧАСТЬ I. БЕЗУСЛОВНАЯ МИНИМИЗАЦИЯ....................................15

Глава 1. Основы теории и методов безусловной минимизации . ... 15

§ 1. Сведения из математического анализа .... 15

§ 2. Условия экстремума.........................................22

§ 3. Существование, единственность, устойчивость минимума ... 25

§ 4. Градиентный метод....................................... 29

§ 5. Метод Ньютона.............................................36

§ 6. Роль теорем сходимости....................................39

Глава 2. Общие схемы исследования итеративных методов..............44

§ 1. Первый метод Ляпунова.....................................44

§ 2. Второй метод Ляпунова.....................................49

§ 3. Другие схемы..............................................59

Глава 3. Методы минимизации........................................63

§ 1. Модификации градиентного метода и метода Ньютона ... 63

§ 2. Многошаговые методы...................................... 68

§ 3. Другие методы первого порядка.............................77

§ 4. Прямые методы.............................................87

Глава 4. Влияние помех.............................................94

§ 1. Источники и типы помех....................................94

§ 2. Градиентный метод при наличии помех.......................97

§ 3. Другие методы минимизации при наличии помех..............100

§ 4. Прямые методы............................................103

§ 5. Оптимальные методы при наличии помех..................... 107

Глава 5. Минимизация недифференцируемых функций...................114

§ 1. Сведения из выпуклого анализа.............................114

§ 2. Условия экстремума, существование, единственность и устойчи-

вость решения..................................................124

§ 3. Субградиентпый метод......................................128

§ 4. Другие методы.............................................134

§ 5. Влияние помех.............................................144

§ 6. Поисковые методы......................................... 146

Глава 6. Вырожденность, миогоэкстремальность, нестационарность . . 150

§ 1. Вырожденный минимум...................................... 150

§ 2. Миогоэкстремальность......................................166

§ 3. Нестационарность..........................................175

4

ОГЛАВЛЕНИЕ

ЧАСТЬ И. УСЛОВНАЯ МИНИМИЗАЦИЯ....................................179

Глава 7. Минимизация на простых множествах.......................179

§ 1. Основы теории............................................179

§ 2. Основные методы..........................................185

§ 3. Другие методы............................................192

§ 4. Влияние помех............................................196

Глава 8. Задачи с ограничениями типа равенств....................199

§ 1. Основы теории............................................199

§ 2. Методы минимизации...................................... 210

§ 3. Учет возможных осложнений................................220

Глава 9. Общая задача математического программирования .... 225

§ 1. Выпуклое программирование (теория)......................225

§ 2. Нелинейное программирование (теория)....................240

§ 3. Методы выпуклого программирования.......................247

§ 4. Методы нелинейного программирования.....................263

Глава 10. Линейное и квадратичное программирование.............. . 268

§ 1. Линейное программирование (теория)......................268

§ 2. Конечные методы линейного программирования..............281

§ 3. Итерационные методы линейного программирования..........288

§ 4. Квадратичное программирование...........................296

ЧАСТЬ III. ПРИКЛАДНОЙ АСПЕКТ............ . , ..................301

Глава 11. Примеры задач оптимизации..............................301

§ 1. Задачи идентификации....................................301

§ 2. Оптимизационные задачи в технике и экономике............317

§ 3. Задачи оптимизации в математике и физике................330

Глава 12. Практическое решение задач оптимизации.................336

§ 1. Процесс решения.........................................336

§ 2. Программы оптимизации...................................340

§ 3. Тестовые задачи и результаты вычислений.................343

Библиографические указания и комментарии.........................361

Литература.......................................................372

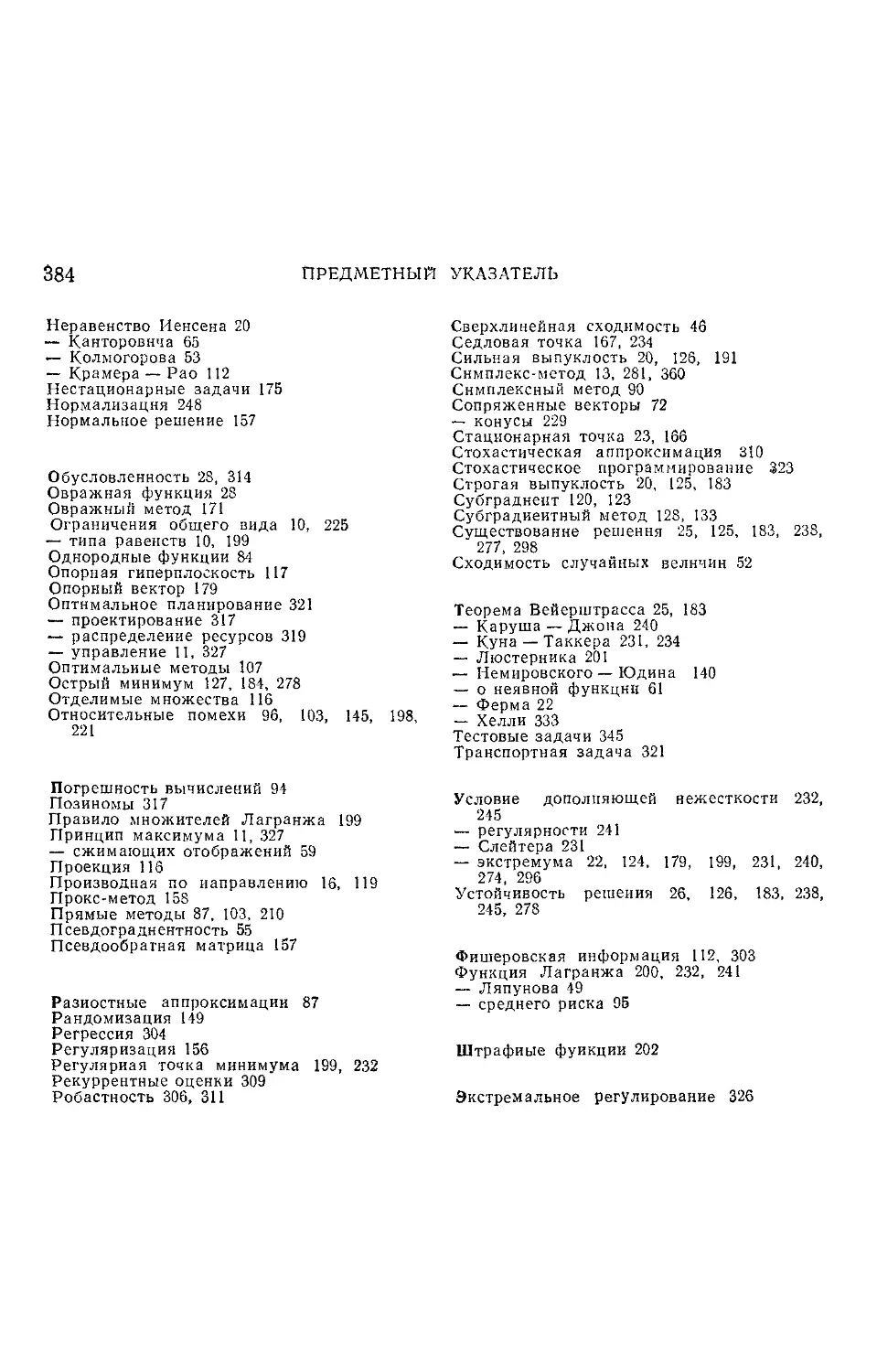

Предметный указатель.............................................383

ПРЕДИСЛОВИЕ

Чрезвычайно широкое распространение задач оптимизации

в технике, экономике, управлении привело к необходимости

ознакомления широкого круга практиков с методами решения

подобных задач. Однако инженеру или вычислителю трудно

ориентироваться в литературе по оптимизации (большинство

имеющихся книг написано «математиками для математиков»),

нелегко разобраться в многообразии задач и алгоритмов. В этой

книге делается попытка систематического изложения основ со-

временной теории и методов оптимизации в форме, доступной

инженеру. Используемый математический аппарат минима-

лен—достаточно знания начал математического анализа, ли-

нейной алгебры и теории вероятностей. Изложение построено

на последовательном усложнении рассматриваемых задач. Вна-

чале описываются наиболее простые задачи безусловной мини-

мизации гладких функций, затем исследуется влияние различ-

ных осложняющих факторов — помех, негладкое™ функций,

вырожденности минимума, наличия ограничений. Анализ каж-

дого класса задач проводится единообразно — вводится требуе-

мый математический аппарат, затем обосновываются условия

экстремума, результаты о существовании, единственности и

устойчивости решения, и, наконец, описываются основные ме-

тоды решения и исследуются их свойства. Главное внимание

уделяется идейным основам методов, их сравнительному ана-

лизу; показано, как теоретические результаты служат фунда-

ментом при построении и изучении методов. На примерах при-

кладных задач оптимизации обсуждается взаимоотношение

общих и специальных методов решения. Дана обширная ком-

ментированная библиография, позволяющая читателю в случае

надобности обратиться к более подробным работам на интере-

сующую его тему.

Включенный в книгу материал во многом отличается от тра-

диционного. Нередко учебники по математическому программи-

рованию сводятся к описанию техники симплекс-метода линей-

ного программирования. Мне этот круг вопросов нс кажется

центральным; ему посвящен лишь один параграф. В то же

время большое внимание уделено задаче безусловной миними-

зации, которая дает богатый материал для обсуждения основ-

ных идей теории и методов оптимизации. Среди нестандартных

разделов книги —задачи негладкой оптимизации, вырожденные

6

ПРЕДИСЛОВИЕ

и нестационарные задачи, задачи с ограничениями типа ра-

венств, условия устойчивости экстремума, влияние помех на ме-

тоды оптимизации, анализ общих схем исследования сходимости

итеративных методов и т. д. Систематически обсуждаются

«наивные» вопросы, которые не принято задавать в математи-

ческой литературе. Например: зачем нужны условия экстре-

мума? Какова польза от теоретических результатов о сходимо-

сти методов? Можно ли реально решать неустойчивые задачи

оптимизации? и т. п.

Книга целиком посвящена конечномерным задачам. Это обу-

словлено как ограничениями на объем работы, так и предпола-

гаемым уровнем математических знаний. Поэтому не рассма-

триваются такие важнейшие вопросы, как современная теория

условий оптимальности в общих экстремальных задачах, за-

дачи вариационного исчисления и оптимального управления

и т. д. Вместе с тем мне кажется, что конечномерный случай

очень богат идеями и результатами; он может служить прекрас-

ной «моделью» более общих задач оптимизации. Знакомый с

функциональным анализом читатель без труда заметит, что

многие утверждения автоматически переносятся на задачи в

гильбертовом или банаховом пространстве, однако в тексте по-

добные обобщения не приводятся. В книгу не включены также

дискретные задачи оптимизации. Они требуют совсем иных ме-

тодов исследования, чем непрерывные, и примыкают к комби-

наторике и математической логике.

Мне неоднократно приходилось читать лекции по теории и

методам оптимизации, в частности в Московском государствен-

ном университете и Институте проблем управления. На их при-

мере я убедился, сколь различен подход к предмету у матема-

тиков, вычислителей и практиков. Предлагаемая книга пред-

ставляет собой попытку некоторого компромиссного решения,

рассчитанного на все эти категории читателей. Обращаясь к

математикам, я хотел бы подчеркнуть, что данная книга —не

учебник, она не связана с имеющимися вузовскими програм-

мами по курсу «методы оптимизации», не все приводимые тео-

ремы доказаны, много материала вынесено для самостоятель-

ной работы в упражнения и т. д. С другой стороны, вычислитель

не найдет окончательных формулировок алгоритмов или гото-

вых текстов программ оптимизации; в работе нет обсуждения

важных деталей вычислительной «технологии»; ряд приводимых

результатов представляет лишь теоретический интерес. Иными

словами, книга не может служить сборником готовых рецептов

решения конкретных задач. Наконец, инженеру или экономисту

придется примириться с несколько абстрактным характером

изложения (примеры и приложения даны лишь в заключитель-

ных главах).

7

СПИСОК ОБОЗНАЧЕНИЙ

Большое значение для меня имела продолжительная совмест-

ная работа с Я- 3. Цыпкиным, который является инициатором

написания этой книги. Постоянная творческая активность

я. 3. Цыпкина, его эрудиция и интерес к задачам оптимизации

оказали серьезное влияние па формирование моих взглядов на

предмет и методологию данной области науки. Я многому

научился у своих учеников; в частности, вычислительный опыт

Е. Н. Белова и В. А. Скокова существенно помог мне при напи-

сании книги. Большой труд по редактированию взял на себя

Ю. Е. Нестеров. Неоценимую помощь в работе над книгой мне

оказала Г. М. Корпелевич. Высокий профессионализм Г. Н. Ар-

хиповой позволил избежать многих трудностей при оформле-

нии рукописи. Всем названным лицам я выражаю глубокую

признательность.

Апрель, 1980 г. Б. Т. Поляк

СПИСОК ОБОЗНАЧЕНИЙ

R" — п-мерное вещественное евклидово пространство.

{хь ..., хп} — компоненты вектора х е R".

|| • II — норма в R": ЩИ2 = *? + + х2.

(•, •) — скалярное произведение в R": (х, у) = хгу{ + ... +х„уп.

I — единичная матрица.

Ат— матрица, транспонированная к А.

А+ — псевдообратная матрица к А (§ 1 гл. 6).

А В — матрицы А и В симметричны и А—В неотрицательно опреде-

лена.

А > В — матрицы А и В симметричны и А—В положительно определена.

||А|| — норма матрицы А: ||А||= шах ||Ах||.

||х|| = 1

р(А) —спектральный радиус матрицы А (§ 1 гл. 2).

х у — все компоненты вектора х е R" не меньше соответствующих

компонент вектора у @ R": Xi Jg yi, i = 1.п.

RlJ. — неотрицательный ортант в R": R" = {х е R": х>о}.

х L — положительная часть вектора х е R": (х+); = max {0, Xi}, i = 1, ...

..., п.

х* = argmin f (x) — любая точка глобального минимума f (х) иа Q:

х @ Q

/(х*) = тЦЦх).

v* хё<2

= Argmin / (х) — множество точек глобального минимума f (х) па Q:

= {х* = argmin f (х)}.

х esQ

W(4. Г(х) — градиент скалярной функции [(х) (§ 1 гл. 1).

Vg(x), g'(x)—производная векторной функции g(x), матрица Якоби

(§ 1 гл. 1).

f"(x)—матрица вторых производных, гессиан (§ 1 гл. 1).

^х (х> У)> Lxx(x, у) — градиент и матрица вторых производных В(х, у)

по переменной х.

ВНх) — субградиент выпуклой функции (§ 1 гл. 5 и § 1 гл 9).

ОеГ(х) — е-субградиент выпуклой функции (§ 1 гл. 5).

8

СПИСОК ОБОЗНАЧЕНИЙ

['(х; у) —производная функции f (х) в точке х по направлению у (§ 1

гл. 1 п § 1 гл. 5).

£)(/) —область определения функции [(х) (§ 1 гл. 5).

Conv Q — выпуклая оболочка множества Q (§ 1 гл. 5).

Q0 - - внутренность множества Q.

0 — пустое множество.

Рр(х) —проекция точки х иа множество Q (§ 1 гл. 5).

р(х, Q) —расстояние от точки х до множества Q:p(x, Q) = inf ||х — у\\.

о(й(х)) — если g: Л: R"->RS н llg(x) ||/||/i (х) ||-> 0 при ||х||->0,

то g(x) = o(h(x)).

O(h(x))—если g: R"Rm, h: R"-*R’ и найдутся e > 0, а такие, что

||g (x) || gc a:’|/i (x) || при ||xil < e, to g (x) О (Л(х)).

о (и*) — если последовательности ut е R", vk e Rm, k = 1, 2 .... таковы,

ЧТО ||U*ll/||£ZjtII 0 при k-+ ос, то vh =

O(Mft)—если для последовательностей lit e R", V/, e Rm, k = 1, 2 ...,

найдутся a > 0, ka такие, что |1щ<|| сД alludl при k kQ, то vk = 0{ик)-

Mg — математическое ожидание случайной величины g.

М (g|x)—условное математическое ожидание случайной величины g, за-

висящей от х, при фиксированном значении х.

V—квантор общности: V.veO--«для всех =

А—знак, ставящийся в конце доказательства (или в конце утвержде-

ния, если последнее приводится без доказательства).

Обычно буквы х, у, а, Ь, .. . используются для обозначения векторов,

а, р, ... — скаляров, А, В, ... — матриц, I. j, k, ... — целых чисел, Q, S,... —

множеств. Итеративная последовательность векторов обозначается х°, х1, ...

. .., хк, . .. ; X; — компоненты вектора х.

Нумерация лемм, теорем и формул в каждом параграфе независимая.

При ссылках в пределах параграфа указывается только помер формулы, в

пределах главы — помер формулы п параграфа, в остальных случаях приво-

дится номер формулы, параграфа и главы.

ВВЕДЕНИЕ

Обычно наши действия в условиях неоднозначности выбора

определяются некоторой целью, которую мы стремимся достичь

наилучшим образом. Тем самым человеческая деятельность свя-

зана с постоянным (сознательным или бессознательным) реше-

нием оптимизационных задач. Более того, многие законы при-

роды носят вариационный характер, хотя здесь и неуместно

говорить о наличии цели.

Можно было бы думать, что подобная распространенность

задач оптимизации должна была найти свое отражение в мате-

матике. Однако в действительности до середины нынешнего

столетия задачи на экстремум рассматривались в математике

лишь эпизодически, развитая теория и методы решения подоб-

ных задач были созданы совсем недавно.

Наиболее простая задача безусловной минимизации функции

многих переменных привлекла внимание математиков во вре-

мена, когда закладывались основы математического анализа.

Она во многом стимулировала создание дифференциального

исчисления, а необходимое условие экстремума (равенство гра-

диента нулю), полученное Ферма в 1629 г., явилось одним из

первых крупных результатов анализа. Позже в работах Нью-

тона и Лейбница были по существу сформулированы условия

экстремума II порядка (т. е. в терминах вторых производных)

для этой задачи.

Другой класс задач на экстремум, традиционно рассматри-

вавшийся в математике, — это задачи вариационного исчисле-

ния. Следы интереса к ним можно найти и в античной мате-

матике (разного рода изопериметрические проблемы), однако

подлинное рождение вариационного исчисления произошло в

конце XVIII века, когда И. Бернулли сформулировал знамени-

тую задачу о брахистохроне. На современном языке классиче-

ская задача вариационного исчисления представляет собой бес-

конечномерную задачу безусловной оптимизации с минимизи-

руемым функционалом специального (интегрального) вида.

Условия экстремума I порядка в вариационном исчислении

были получены Эйлером (уравнение Эйлера), а II порядка —

Лежандром и Якоби. Важный вопрос о существовании решения

в вариационном исчислении был впервые поставлен Вейер-

штрассом во второй половине XIX века.

Обе задачи, о которых говорилось выше (конечномерная и

бесконечномерная), являются примерами задач безусловной

10

ВВЕДЕНИЕ

минимизации. Задачи на условный экстремум рассматривались

в классической математике лишь для ограничений типа равенств.

Знаменитое правило множителей Лагранжа (сформулированное

в XVIII веке) представляет собой необходимое условие экстре-

мума I порядка в подобных задачах (и в конечномерных, и в

задачах вариационного исчисления). Поразительно, что такие

же условия для задач с ограничениями типа неравенств были

получены лишь недавно. Сами по себе системы неравенств (вне

связи с задачами минимизации) изучали Фурье, Минковский,

Вейль и другие ученые; созданный ими аппарат позволял без

труда получить условия экстремума в задачах с ограниче-

ниями— неравенствами.

Первые работы по экстремальным задачам при наличии

ограничений общего вида относятся к концу 30-х — началу

40-х годов нашего века. Корни этих работ были различны.

Специалистов по вариационному исчислению, принадлежавших

к Чикагской школе (Блисс, Больца, Макшейн, Грейвс, Хестенс

и др.), стимулировал интерес возможно более широкой поста-

новки вариационных задач. Здесь в 1937 г. появилась работа

Валентайна, посвященная условиям экстремума для задач ва-

риационного исчисления при наличии разного рода ограничений

типа неравенств. Позже были созданы (Макшейн, Кокс) общие

схемы анализа абстрактных экстремальных задач. Одному из

аспирантов Чикагского университета, Карушу, было поручено

исследовать в качестве упражнения конечномерные задачи ми-

нимизации с общими ограничениями. Каруш получил в 1939 г.

условия экстремума первого и второго порядков для гладкого

случая; к 'его работе не отнеслись серьезно, и она не была опу-

бликована. К тем же по существу условиям экстремума не-

сколько позже пришел американский математик Фриц Джон,

занимавшийся экстремальными проблемами в геометрии (типа

отыскания эллипсоида наименьшего объема, описанного вокруг

заданного выпуклого тела). Работа Джона была отвергнута

одним серьезным математическим журналом и была напечатана

лишь в 1949 г.

Независимо от американских исследований оптимизацион-

ная тематика развивалась и в СССР. Пионером в этой области

был Л. В. Канторович, опубликовавший в 1939 г. книгу, содер-

жавшую математические постановки ряда экономических задач.

Последние не укладывались в рамки стандартного математи-

ческого аппарата, а именно, являлись задачами минимизации

линейной функции на множестве, задаваемом линейными огра-

ничениями типа равенств и неравенств. Л. В. Канторович раз-

работал теорию подобных задач и предложил некоторые (не

полностью алгоритмизованные) методы их решения. В 1940 г.

появилась заметка того же автора, содержавшая общую форму-

лировку условий экстремума при наличии ограничений в беско-

ВВЕДЕНИЕ

11

нечномерном пространстве. Работы Л. В. Канторовича в то

время не привлекли внимания математиков и остались, по су-

ществу, незамеченными. Как видит читатель, судьба не благо-

приятствовала первым исследованиям по пеклассическим за-

дачам оптимизации.

Время для них созрело несколько позже, в конце 40-х годов.

Под влиянием прикладной тематики, которой ему приходилось

заниматься в годы войны, Данциг в США стал изучать задачи

минимизации линейной функции при линейных ограничениях,

получившие название задач линейного программирования. Он

сформулировал условия оптимальности решений в линейном

программировании. Под влиянием работ фон Неймана по тео-

рии игр, Данциг, Гейл, Кун и Таккер создали теорию двойствен-

ности в линейном программировании — специфическую форму-

лировку условий экстремума.

Вскоре после разработки теории линейного программирова-

ния возникает ее естественное обобщение на нелинейный слу-

чай. Задача минимизации нелинейной функции при нелинейных

ограничениях была названа задачей математического програм-

мирования (что вряд ли можно признать удачным, учитывая

перегруженность обоих терминов). Если и минимизируемая

функция, и ограничения выпуклы, то говорят о задаче выпук-

лого программирования. Условия экстремума для задач мате-

матического программирования стали широко известны после

работы Куна и Таккера 1950 г.; по существу, это были те же

условия Каруша — Джона. Для выпуклого случая Кун и Так-

кер сформулировали условия экстремума в терминах седловой

точки; эта формулировка пригодна и для негладких

задач.

Существенный прогресс в теории оптимизации был достигнут

при изучении так называемых задач оптимального управления,

являющихся непосредственным обобщением классической за-

дачи вариационного исчисления и заключающихся в оптимиза-

ции функционалов от решений обыкновенных дифференциаль-

ных уравнений, правые части которых включают подлежащие

выбору функции («управления»). Необходимые условия опти-

мальности для этих задач были сформулированы и доказаны

Л. С. Понтрягиным, В. Г. Болтянским и Р. В. Гамкрелидзе в

1956—1958 гг. в форме так называемого принципа максимума.

В иной форме условия оптимальности для подобных задач были

получены Веллманом на основе идей динамического програм-

мирования. Эти результаты были столь связаны со специфиче-

ской формой задач оптимального управления, что не сразу

было осознано их родство с условиями экстремума для задач

математического программирования.

л Р годы появился цикл работ (А. Я. Дубовицкого и

А. А. Милютина, Б. Н. Пшеничного, Нейштадта, Халкина, Варги

12

ВВЕДЕНИЕ

и других авторов), в которых были предложены общие схемы

получения условий экстремума для абстрактных задач оптими-

зации с ограничениями, позволившие охватить как теорему

Куна — Таккера, так и принцип максимума. Это дало возмож-

ность по-новому взглянуть на известные результаты и, в част-

ности, выделить в них стандартную часть, которую можно полу-

чить с помощью общих схем, и нестандартную, связанную со

спецификой задачи. Удобным аппаратом для исследования

экстремальных задач оказался выпуклый анализ — сравни-

тельно новый раздел математики, получивший завершенную

форму в работах Р. Рокафеллара. В настоящее время тех-

ника вывода условий оптимальности развита в совершен-

стве.

Выше в основнохм говорилось о той части теории оптимиза-

ции, которая связана с условиями экстремума. Однако найти

с помощью условий экстремума явное решение задачи удается

лишь в редких случаях. Сложность или невозможность отыска-

ния аналитического решения обнаружилась и в других разделах

математики; постепенно стало ясно, что любая задача может

считаться решенной, если указан алгоритм, позволяющий чис-

ленно построить приближенное решение с требуемой точностью.

Этот принципиально новый подход, подкрепленный появлением

ЭВМ и приведший к возникновению вычислительной матема-

тики, существенно затронул и проблематику оптимизации. Од-

ним из центральных направлений здесь стала разработка и обо-

снование численных методов решения.

Математиков прошлого относительно мало интересовали вы-

числительные проблемы, и хотя некоторые методы решения не-

линейных уравнений и безусловной минимизации связывают с

именами Ньютона, Гаусса, Коши, эти результаты оставались

изолированными в творчестве упомянутых ученых и их после-

дователей.

Пожалуй, первыми нужду в численных методах минимиза-

ции испытали статистики. В задачах оценки параметров при-

менение метода максимального правдоподобия или метода наи-

меньших квадратов приводило к необходимости отыскания

экстремума функции многих переменных (вообще говоря, неква-

дратичной). Статистикам (Карри, Левенбергу, Крокету, Чер-

нову и другим) принадлежат первые исследования по числен-

ным методам безусловной минимизации, выполненные в 40-х—

50-х годах. В связи с проблемами планирования эксперимента

и решения уравнений регрессии в работах Бокса, Роббинса и

Монро, Кифера и Вольфовица в начале 50-х годов были пред-

ложены методы минимизации функций при наличии случайных

помех.

Другим разделом математики, где происходило зарождение

методов оптимизации, была линейная алгебра. Необходимость

ВВЕДЕНИЕ

13

решения больших систем линейных уравнений, возникающих

при конечно-разностной аппроксимации уравнений с частными

производными, привела к развитию итеративных методов линей-

ной алгебры. Но задача решения системы линейных уравнений

эквивалентна минимизации квадратичной функции, и многие

итеративные методы удобно строить и обосновывать, опираясь

на этот факт. Таковы методы покоординатного спуска, наиско-

рейшего спуска, сопряженных градиентов и ряд других методов,

которые были созданы в линейной алгебре к началу 50-х годов.

Естественным шагом было перенесение подобных методов на

неквадратичный случай.

С необходимостью решения задач оптимизации столкнулись

и специалисты по теории автоматического регулирования. Тру-

дами В. В. Казакевича, А. А. Фельдбаума, А. А. Первозванского

в 50-х годах была создана теория экстремального регулирова-

ния и предложены специальные методы оптимизации действую-

щих объектов в реальном масштабе времени.

Первый численный метод нелинейного программирования —

метод штрафных функций — был введен Курантом в 1943 г. из

соображений, связанных с физической природой рассматри-

вавшейся задачи.

Наконец, мощный импульс для развития методов оптимиза-

ции дал предложенный Данцигом в конце 40-х годов симплекс-

метод для решения задач линейного программирования. Оби-

лие приложений и наличие хороших программ для ЭВМ при-

вели к широкой популярности симплекс-метода прежде всего

среди экономистов.

До какого-то времени такого рода исследования были спора-

дическими и не объединялись ни единым подходом, ни аппара-

том. Однако к середине 60-х годов в рамках вычислительной

математики сложилось самостоятельное направление, связан-

ное с численными методами оптимизации. С тех пор непрерывно

шло интенсивное развитие этого направления как вширь (раз-

работка новых методов, исследование новых классов задач), так

и вглубь (выработка единого аппарата для анализа сходимости

и скорости сходимости, классификация и унификация методов).

В настоящее время эта область вычислительной математики

может считаться окончательно сформировавшейся. Разработано

множество численных методов для всех основных классов за-

дач оптимизации — безусловной минимизации гладких и неглад-

ких функций в конечномерных и бесконечномерных пространст-

вах, условной минимизации при ограничениях типа равенств

и (или) неравенств в выпуклом или невыпуклом случае и т. д.

Для большинства методов имеется строгое обоснование, выяс-

нена скорость сходимости, установлена область применимости.

Конечно, многие проблемы еще не решены до копца (построение

14

ВВЕДЕНИЕ

эффективных методов для некоторых специальных типов задач,

проблема оптимальных методов, подробная численная проверка

имеющихся алгоритмов, создание доступных и отработанных

машинных программ и т. п.). Однако, по-видимому, период наи-

большей активности в области численных методов оптимизации

остался позади.

В предлагаемой вниманию читателя книге делается попытка

систематического изложения современного состояния основ

оптимизации.

ЧАСТЬ I

БЕЗУСЛОВНАЯ МИНИМИЗАЦИЯ

Глава 1

ОСНОВЫ ТЕОРИИ И МЕТОДОВ БЕЗУСЛОВНОЙ

МИНИМИЗАЦИИ

Мы начинаем изучение проблем оптимизации с классической

задачи безусловной минимизации гладкой функции:

min f (х), х е Rra.

Этой задаче будет уделено большое внимание не только из-за

ее важности, но и потому, что в силу ее простоты для нее наибо-

лее четко видна схема математического исследования общих

оптимизационных задач и идейные основы методов оптимизации.

§ 1. Сведения из математического анализа

1. Дифференцирование скалярных функций. Скалярная

функция f(x) «-мерного аргумента х (кратко это записывается

f: R«->R> ) называется дифференцируемой в точке х, если най-

дется вектор а е R" такой, что для всех i/eR"

f(x + f/) = f(x) + (a, у) + о(у). (1)

Вектор а в (1) называется производной или градиентом

функции f(x) в точке х и обозначается f'(x) или Vf(x). Итак,

градиент определяется равенством

f (х + у) = f (х) + (Vf (х), у) + о (у). (2)

Иначе можно сказать, что функция дифференцируема в точке

х, если она допускает линейную аппроксимацию первого порядка

в этой точке, т. е. найдется линейная функция f(^) = /(x) +

+ (Vf(x), у) такая, что |f(x-]-z/)— f (у) \ — о(у). Ясно, что гра-

диент определяется однозначно, при этом Vf(x) — вектор с ком-

понентами (df(x)/dxi, ..., df(x)/dxn). Вычислять градиент

можно, во-первых, непосредственно из определения, во-вторых,

с помощью его координатной записи и, в-третьих, с помощью

правила дифференцирования сложной функции (см. ниже (12)).

Пусть, например, f(x)—квадратичная функция

f(x) = (Ax, х)/2 —(6, х),

где А — симметричная «X «-матрица, b е R". Тогда f(x + ^) =

== (Д(х+г/), х + у)/2-(Ь, (х + у)) = (Ах, х)/2- (Ь, х) +

-НАх-б, у) + (Ау, y)/2 = f(x) + (Ax-b, у) + (Ау, у)/2. Но

I Иг/, У) | X НАШИ2, поэтому (Ау, у)/2 = о(у). Итак, f(x) диф-

ференцируема в любой точке х и

Vf(x) = Ax — b. (3)

16

ГЛ. 1. ТЕОРИЯ И МЕТОДЫ БЕЗУСЛОВНОЙ МИНИМИЗАЦИИ

Функция f(x) называется дифференцируемой на множестве

QczRn, если она дифференцируема во всех точках Q. Если f(x)

дифференцируема на всем пространстве R", то говорят просто,

что она дифференцируема.

Пусть f(x) дифференцируема на отрезке [х, х + у] (т. е. для

точек вида х -ф ту, 0 кф т 1). Рассмотрим функцию одного пе-

ременного ф(т) = f(x + ту) и вычислим ее производную для

Оцфтгф 1:

Ф (т + Ат) — ф (г) f (х + (г + Аг) у) — + ту) =

Ат Ат

__(W (* + ту), Ату) + о (Ату)

Ат ’

ф' (т) = lim ф (т + \v~ '-Т) = (vf (х + т>У), У).

Ат-»0

Таким образом, ф(т) дифференцируема на [0, 1] и

ф/(т) = (УНх + тг/), у). (4)

Величина

№ У) = Нт (5)

е-»+0 8

называется производной по направлению (или вариацией) функ-

ции f(x) в точке х по направлению у. Производная по направ-

лению может существовать и для негладких функций. Напри-

мер, для f(x)=||x|| имеем f(0; у) = \\у\\. Если f(x) имеет в

точке х производную по всем направлениям, линейную по у.

f'(х; у) — (а, у), то говорят, что f(x) дифференцируема по Гато

в точке х. Такая функция имеет частные производные, причем

f'(x; ei) = df(x)/dxi (et — координатные орты), a — (df/dxit ...

.... df/dXn). Из формулы (4) следует, что если f(x) дифферен-

цируема в точке х, то она дифференцируема и по Гато, причем

f' (х; у) = ф' (0) = (Vf (х), у). (6)

Обратное, вообще говоря, неверно. Например, функция f-

R1, /7 фг 2, вида

fl, если || х — а || = || а ||, х ф= 0,

f (х) = S п (7)

(.0 в остальных точках,

где а <= R", а 0, дифференцируема в точке 0 по любому на-

правлению и f(0; у) — 0 для всех у, т. е. она дифференцируема

по Гато в нуле, однако она не дифференцируема (и даже не

непрерывна) в этой точке. Отметим еще, что иногда (чтобы под-

черкнуть отличие от дифференцируемости по Гато) употреб-

ляют термин «дифференцируемость по Фреше» вместо «диффе-

ренцируемость».

§ I. СВЕДЕНИЯ ИЗ МАТЕМАТИЧЕСКОГО АНАЛИЗА 17

Если функция f(x) дифференцируема на [х, х + у], то, поль-

зуясь (4) и формулой Ньютона —Лейбница ф(1) = <р(0)4-

। ^ф'(т)г/т, получаем запись остаточного члена в (2) в инте-

О

тральной форме:

1

f (X + у) = f W + J (V/ (х + ту), у) ах =

О

1

= / (х) + (V/ (х), у) + J (Vf (у + ту) — V/ (х), у) dx. (8)

о

Другой полезный результат — теорема о среднем — следует

из формулы конечных приращений <р(1) = <р(0) + <р'(6), 0 кф

0 < 1, и (4):

Цх + У) = f W + (V) (х + 0у)> У), (9)

где 0 0 1 — некоторое число.

Упражнения.

1. Докажите, что: a) Т||х|| = х/||х|| при х 0; при х = 0 функция |Д|!

недифференцируема; б) Vii-Т-Д!3 = 2х+.

2. Докажите, что из непрерывности по х производной Гато следует диф-

ференцируемость.

2. Дифференцирование векторных функций. До сих пор речь

шла о дифференцируемости скалярных функций. Совершенно

аналогично определяется дифференцируемость векторных функ-

ций. Функция g: называется дифференцируемой в точке

х, если найдется матрица А размерности m X а такая, что для

всех у е R"

g^ + y) = g(x)A-Ау + о(у'). (10)

Матрица А называется производной или матрицей Якоби ото-

бражения g'(x), и для нее применяется то же обозначение g'(х)

или Vg(x), что и в скалярном случае. Итак,

g-(x + y) = y(x) + y'(x)y + o(y), (Ц)

т. е. дифференцируемая в точке х функция допускает в этой

точке линейную аппроксимацию первого порядка. Очевидно, что

для дифференцируемой векторной функции g (х) — (o-t (х), ...

g'm(x)) элементы матрицы Якоби определяются формулой

g'W<7 = dgi(x)/dxj.

Пусть g: R"-> — дифференцируемая в точке х функция,

a h: Rm->RS дифференцируема в точке g(x). Тогда спра-

ведливо правило дифференцирования сложных функций

[Л (g (*))]' —/г' / (х), (12)

где в правой части стоит произведение матриц ф л g\

18

ГЛ. 1. ТЕОРИЯ И МЕТОДЫ БЕЗУСЛОВНОЙ МИНИМИЗАЦИИ

Теорема о среднем для векторных функций неверна, т. е., во-

обще говоря, не существует такого О сф О 1, что

g (х + у) = g (х) + g' (х + 9г/) У

для дифференцируемой на [х, х -ф у] функции g: R'!->Rm,

т>1. Однако справедлива формула, аналогичная (8): если

g(x) дифференцируема на [х, х + у] > то

1

g (х + У) = g (х) + (* + ху) у dr =

О

1

= g(x) + g'(x)y + 5 (g' (х + ту) — g' (х)) у dr. (13)

о

Из формулы (13), в частности, получаем следующие полез-

ные оценки. Если ||/У(х + ху) || L при О т 1, то

||g(x + У) — g(x)||<L|| 1/||, (14)

а если g'(x) удовлетворяет условию Липшица на [х, х-^-'у]:

llg'(u) — £Г'О) II vll, и, V (=[х, х + у], то

II g (X + у) — g (х) — g' (х) у II < LII у 1172. (15)

Как и в скалярном случае, функция g: R"->Rm, дифферен-

цируемая во всех точках R", называется дифференцируемой.

Упражнение.

3. Используя (12) и результат упражнения 1, покажите, что VI! (Ах —

— &)+И2 — 24z(Ах— &)+, где А — матрица хрХ п.

3. Вторые производные. Скалярная функция f(x) на R" на-

зывается дважды дифференцируемой в точке х, если она диф-

ференцируема в этой точке и найдется симметричная п X «-ма-

трица Н такая, что для всех у R"

f (х + У) = f (х) + (Vf (х), у) + (Ну, у)/2 + о(\\у ||2). (16)

Эта матрица называется матрицей вторых производных, матри-

цей Гессе или гессианом и обозначается /’"(х) или V2f(x). Иначе

говоря, функция дважды дифференцируема в точке х, если она

допускает квадратичную аппроксимацию второго порядка в

окрестности этой точки, т. е. существует квадратичная функция

f(y) = f<x) + (yf(x), z/) + (V2f(x)z/, у)/2 такая, что | f (х + у) --

— 1(У) I = о(Й112).

Уточним полученные ранее оценки для дважды дифференци-

руемых функций. Рассмотрим вновь скалярную функцию ф(т) =

= f(x + ту) в предположении, что f дважды дифференцируема

§ 1. СВЕДЕНИЯ ИЗ МАТЕМАТИЧЕСКОГО АНАЛИЗА '

19

на [х, х + у]. Так же, как и выше, показывается, что эта функ-

ция дважды дифференцируема и

qp"(r)==(V2f (х + ту)у, у). (17)

Тогда из формулы Тейлора с остаточным членом в инте-

1 t

гральной форме ср (1) == Ф (0) + q/ (0) + q>" (х) dx dt следует

о о

1 t

f(x + t/) = f(x) + (Vf(x), у) + J + y)d%dt. (18)

о о

В частности, если |[V2f(x ту) || Е для 0 т 1, то отсюда

получаем

\f(x + y)-f(x)-(Vf(x), y)\^(L/2)\\y\\2, (19)

а если || V2/ (х + ту) — (х) || < Lt || у ||, то

I f (х + у) - f (х) - (V/ (х), у) - (>/2) (V2/ (х) у, у) К (А/6) IIУII3. (20)

Если же пользоваться формулой Тейлора с остаточным членом

в форме Лагранжа

Ф(1) = Ф(0) + ф'(0) + ф"(0)/2, О<0<Я,

то получаем, что найдется 0 0 1, для которого

f (х + у\) = f (х) + (vf (х), у) + (V2/' (х + 0у) у, у)/2. (21)

Упражнения.

4. Покажите, что V3)(x)—матрица с элементами d2f(x)ldxidx/.

5, Докажите, что-, a) V2[(Ax, х)/2—(Ь, а)] = А, где А — симметричная

«X «-матрица, b eR"; б) V'2Wi = /IWI-1 — ххт || х|| -3 для a=/=0; в) V2(c, а)2=

= 2ссг, с е R’’.

6. Проверьте, что f"(x) = (f'(x))', т. е. производная векторной функции

f'(x) совпадает со второй производной f(x).

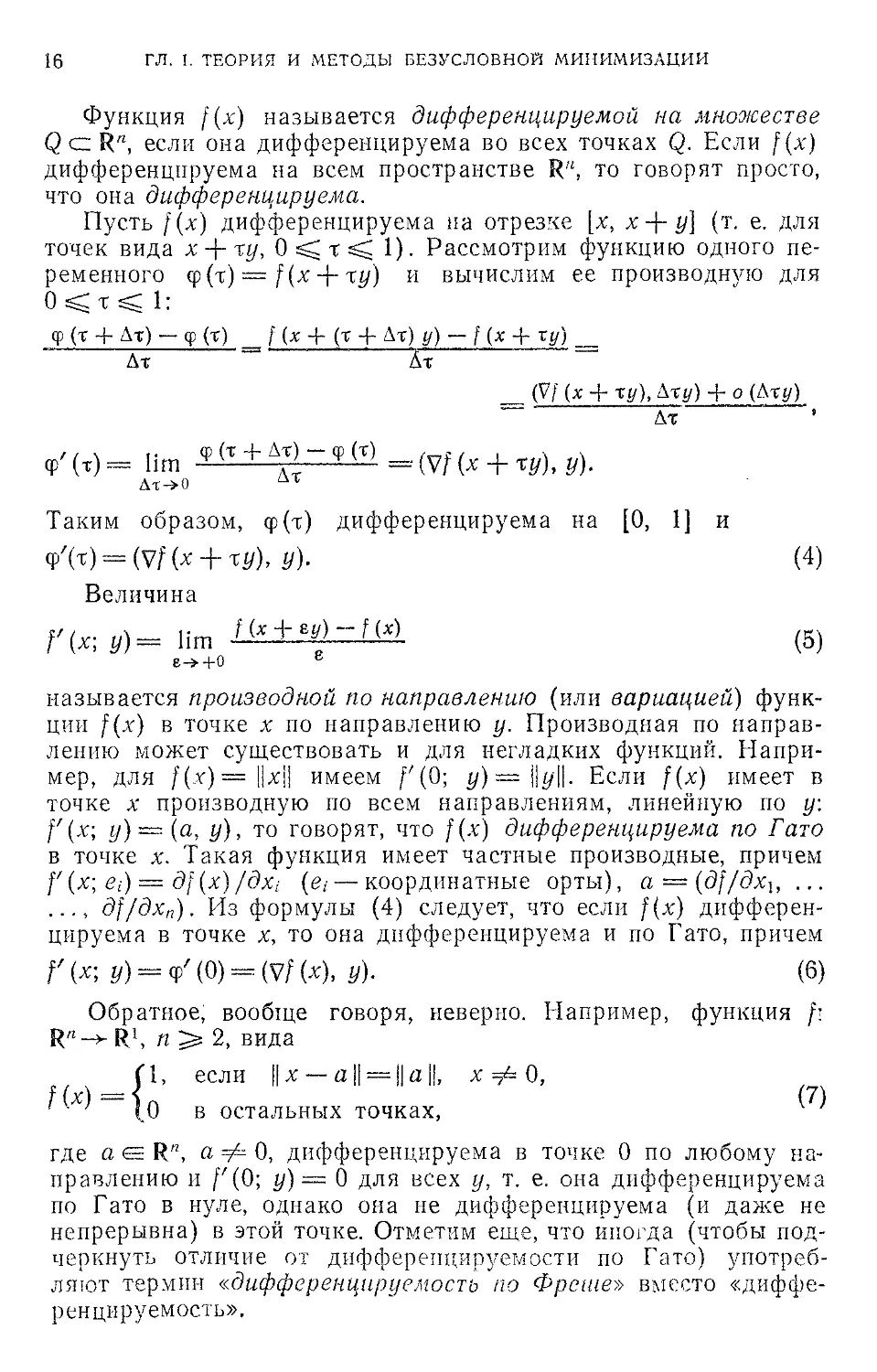

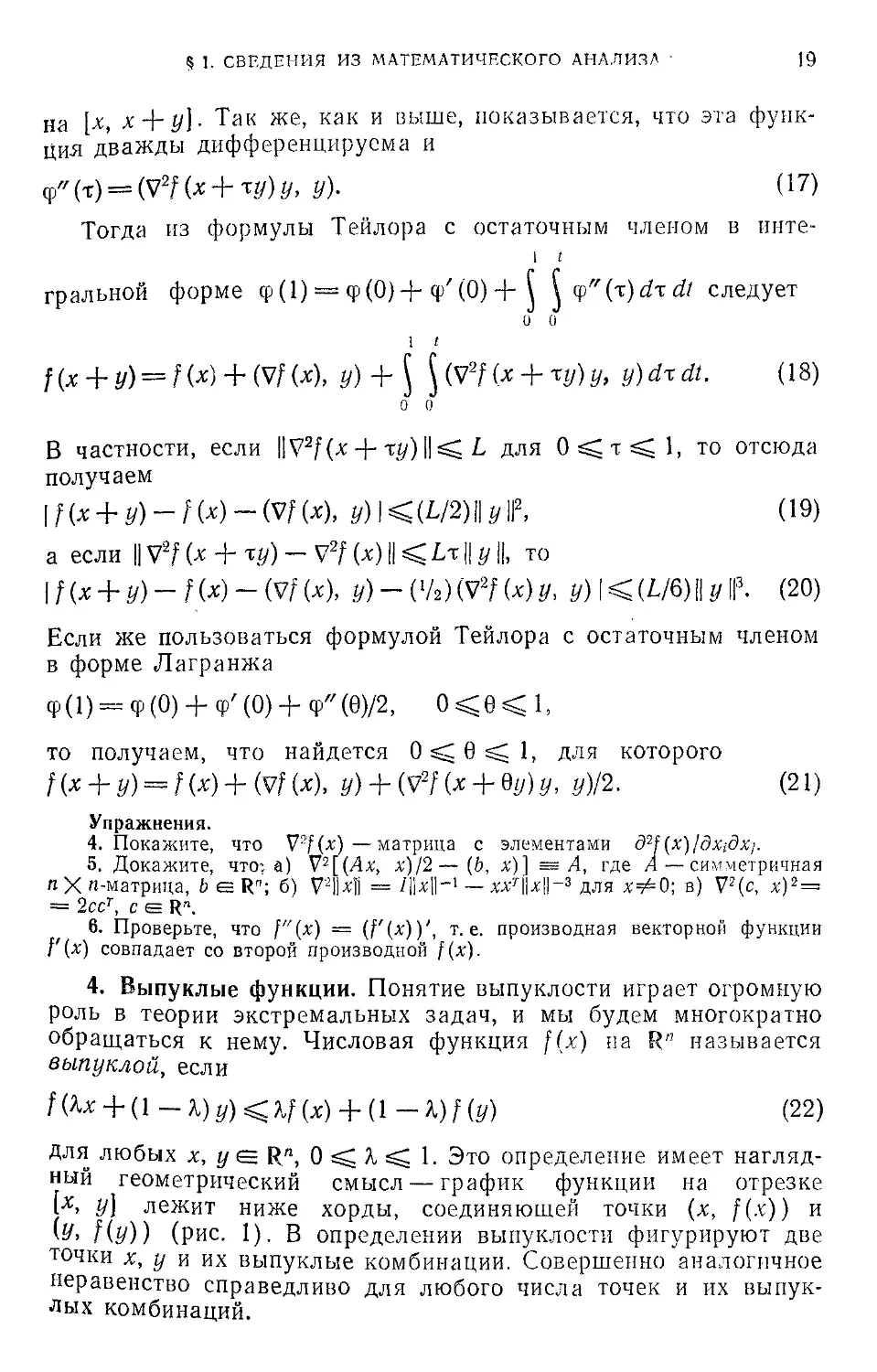

4. Выпуклые функции. Понятие выпуклости играет огромную

роль в теории экстремальных задач, и мы будем многократно

обращаться к нему. Числовая функция f(x) на R" называется

выпуклой, если

f (Ах + (1 - X) у) < If (х) + (1 - Л) f (у) (22)

Для любых х, у е R", 0 А 1- Это определение имеет нагляд-

ный геометрический смысл — график функции на отрезке

[х, у] лежит ниже хорды, соединяющей точки (х, f(x)) и

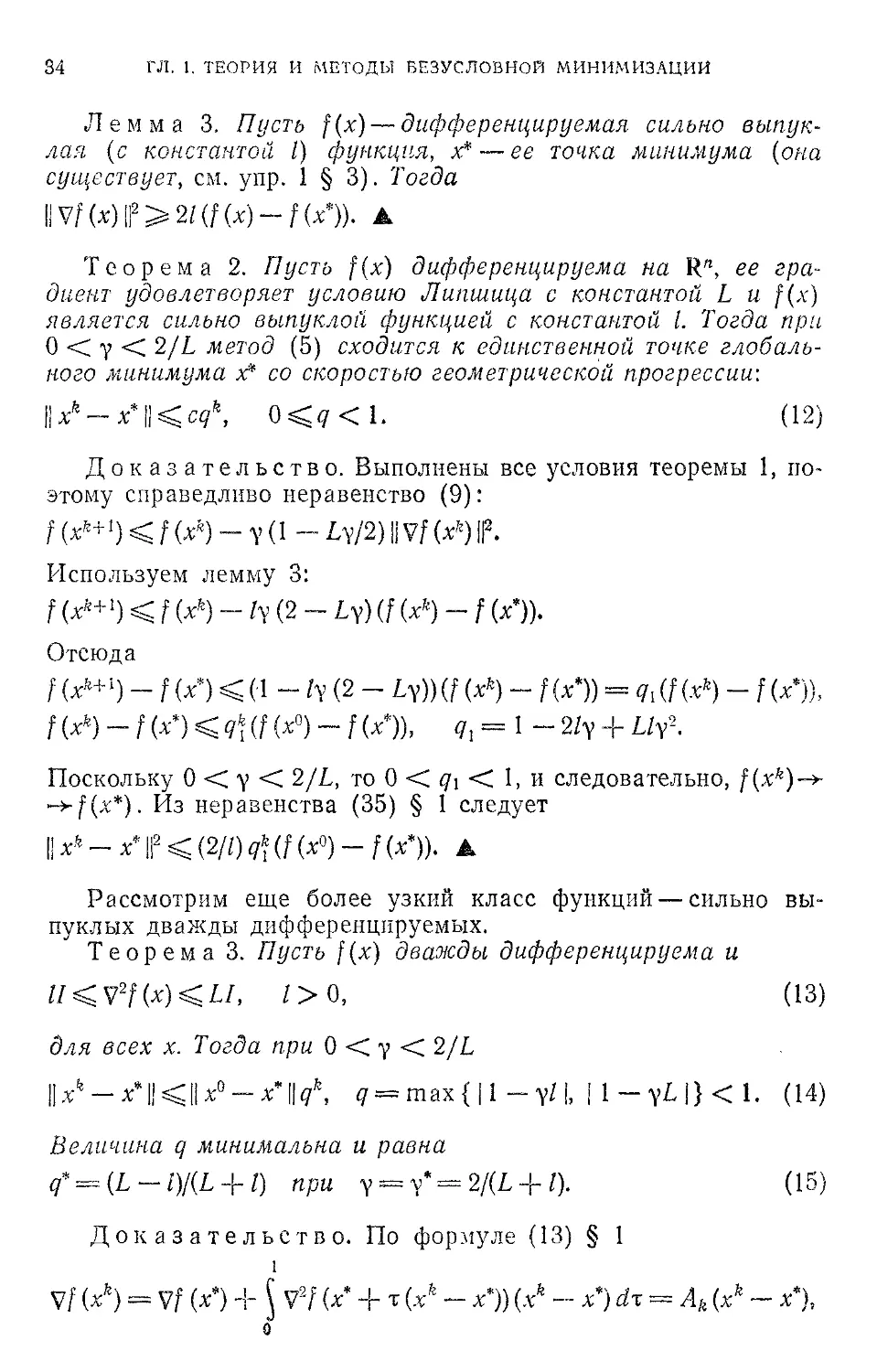

(У, Ну)) (рис. 1). В определении выпуклости фигурируют две

точки х, у и их выпуклые комбинации. Совершенно аналогичное

неравенство справедливо для любого числа точек и их выпук-

лых комбинаций.

20

ГЛ. 1. ТЕОРИЯ И МЕТОДЫ БЕЗУСЛОВНОЙ МИНИМИЗАЦИИ

Лемма 1 (неравенство Йенсена). Пусть f{х) — выпуклая

функция на R”. Тогда для любых х1, ..., хл стл R" и ф? 0,

k

k, У О = 1,

г-1

Жх!+ ... WKWH ••• + W(A А (23)

Функция f(x), для которой —f(x) является выпуклой, на-

зывается вогнутой Очевидно, что аффинная функция /(х) =

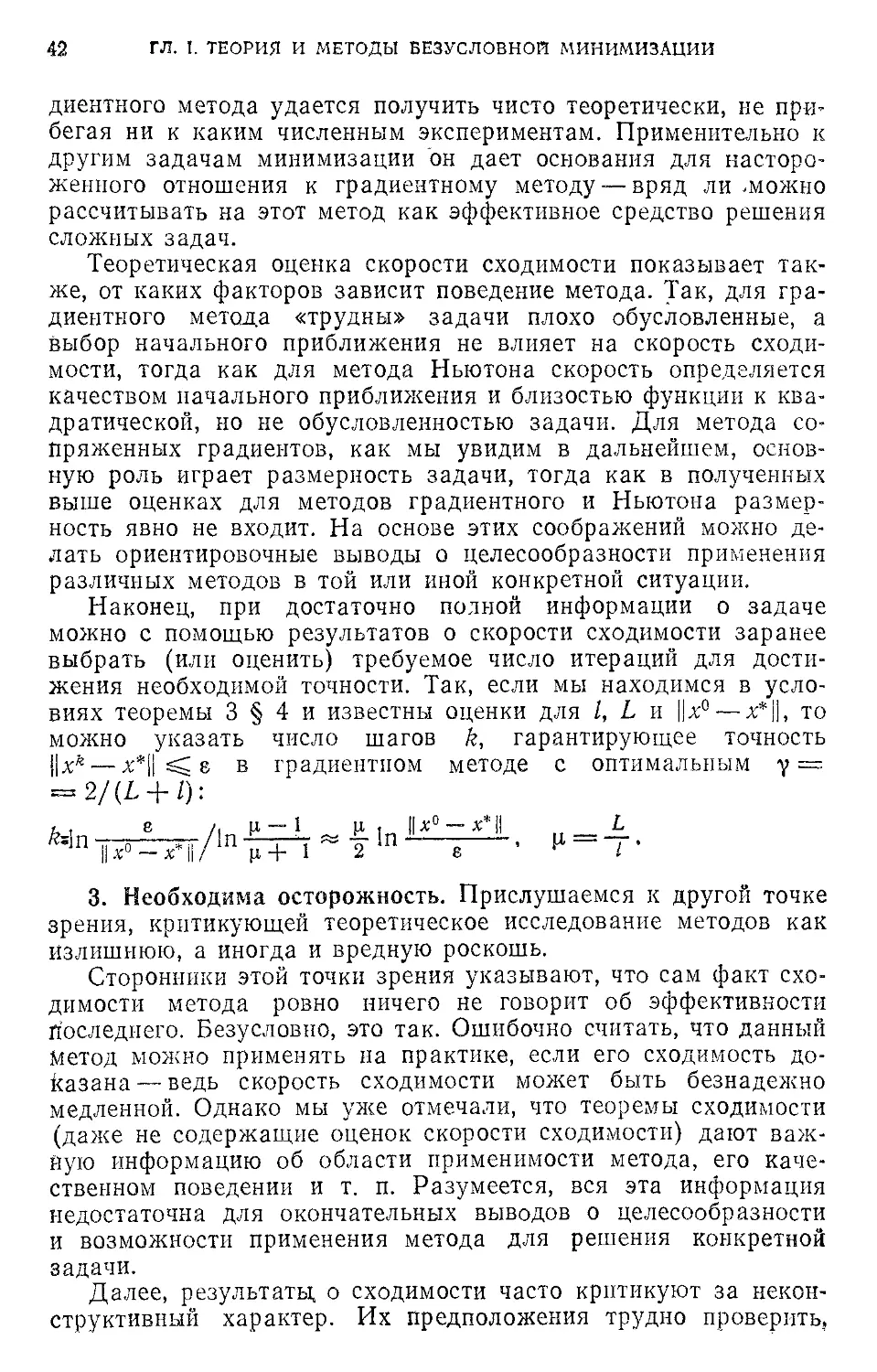

х Ах+Ю-Кд у

Рис. 1. Выпуклая функция.

ции. Функция f(x) на R"

любых х у, 0 < /. < 1,

= (а, х) + [J является и выпук-

лой и вогнутой.

Из определения очевидно, что

если )i(x) выпуклы, t=l,..., tn, то

ГП

И f(x)= Е Vifdx), уz>0, и

г = 1

f (х) ~~ max fi(x) также будут

I < г < m

выпуклы.

Важным частным случаем

выпуклых функций являются

строго и сильно выпуклые функ-

называется строго выпуклой, если для

f (%х + (1 - %) у) < U (х) + (!-%)/ (г/),

(24)

и сильно выпуклой с константой I 0, если при 0 А щ 1

ИХх + (1 - %) г/)< V (х) + (1 ~ 'М f (У) ~ & (1 - X) О х - у ||2/2. (25)

Ясно, что сильно выпуклая функция строго выпукла.

Важно иметь аналитические критерии, по которым можно

судить о выпуклости функций. Такие критерии существуют и

очень просты для случая дифференцируемых функций. Они

основываются на следующем элементарном результате.

Лемма 2. Пусть ф(т)— дифференцируемая функция на

R!. Тогда выпуклость ф(т) эквивалентна монотонности произ-

водной (4>'(ti) ф'Стг) при тц^тг), строгая выпуклость —

строгой монотонности (ф'(т1) > Ф'Ч'Гг) при ti>t2), а сильная

выпуклость — сильной монотонности (ф(Т1)—Ф(Т2)^/(Т1 — та),

Т1 > т2). ▲

Лемма 3. Для дифференцируемой функции f(x) на R" вы-

пуклость эквивалентна неравенству

fix + у) > f (х) + (Vf (х), у),

строгая выпуклость — неравенству

f (х + у) > f(x) + (vf (х), у), у 0,

(26)

(27)

§ 1. СВЕДЕНИЯ ИЗ МАТЕМАТИЧЕСКОГО АНАЛИЗА

21

а сильная выпуклость — неравенству

f (х + У) > f W + (V/ (х), у) + III У 1г/2 (28)

для любых х, у Rr‘. ▲

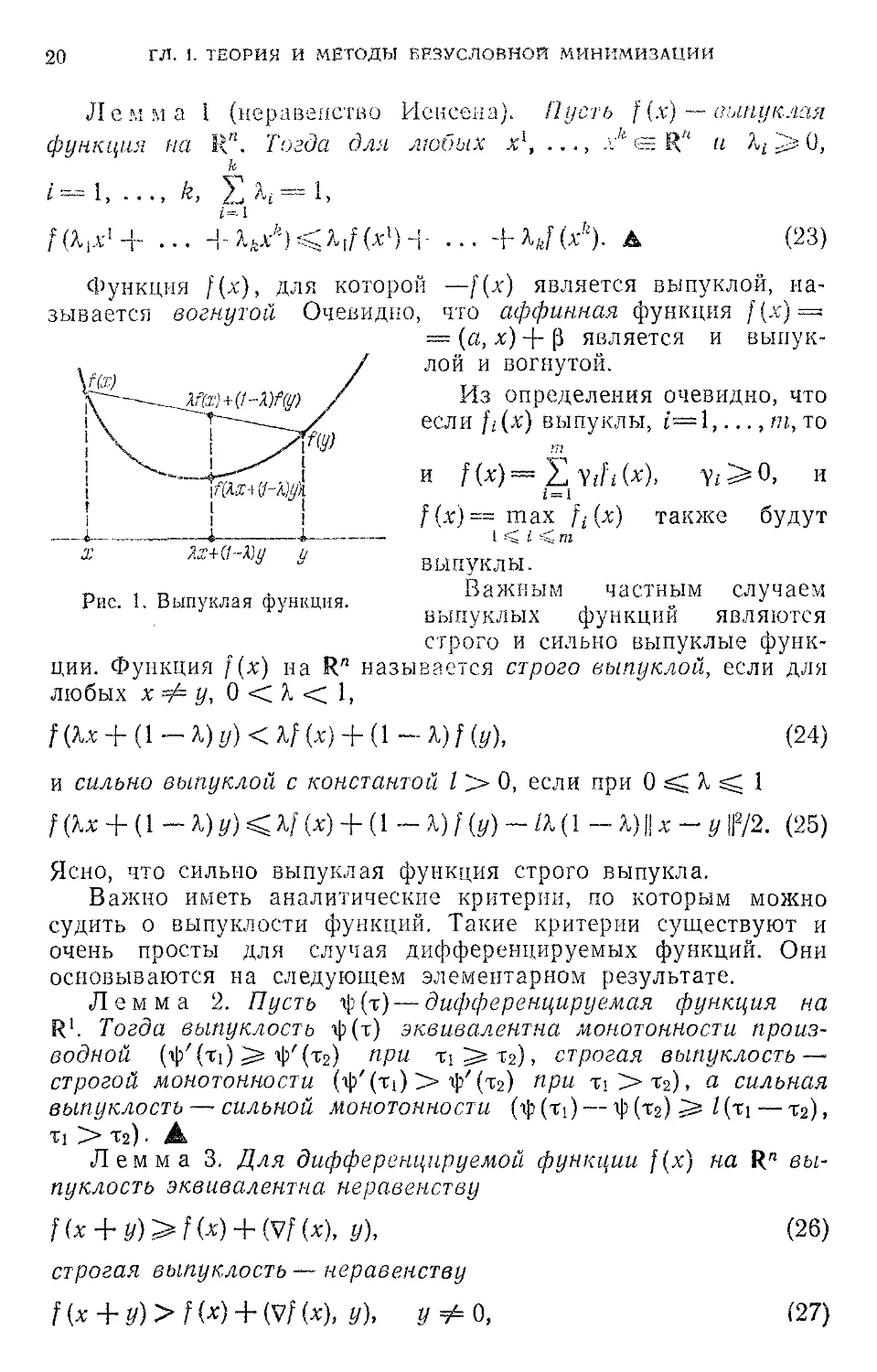

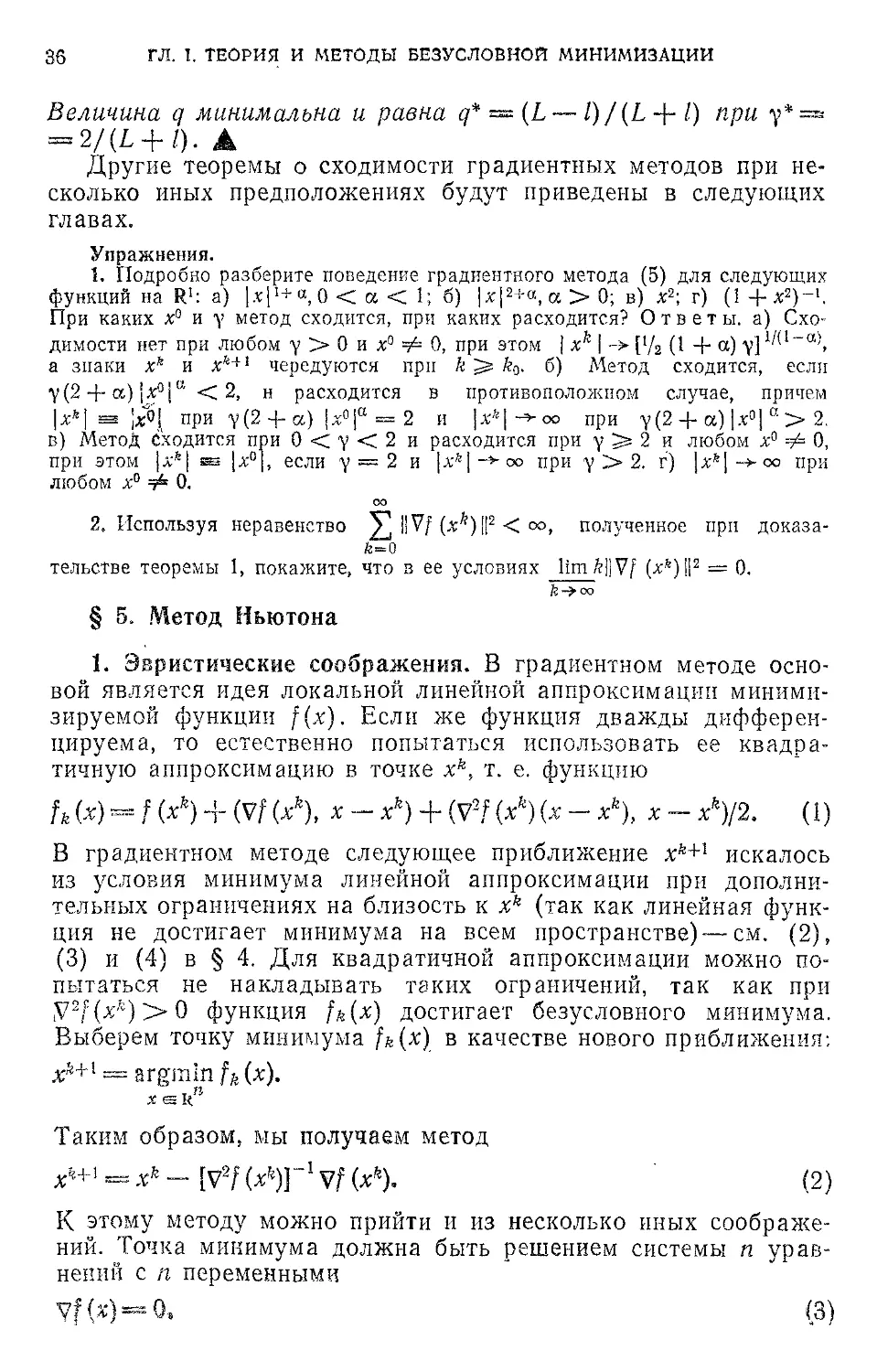

Иначе говоря, график (строго) выпуклой функции лежит

(строго) выше касательной гиперплоскости, а для сильно вы-

пуклой функции график лежит выше некоторою параболоида

(рис. 2).

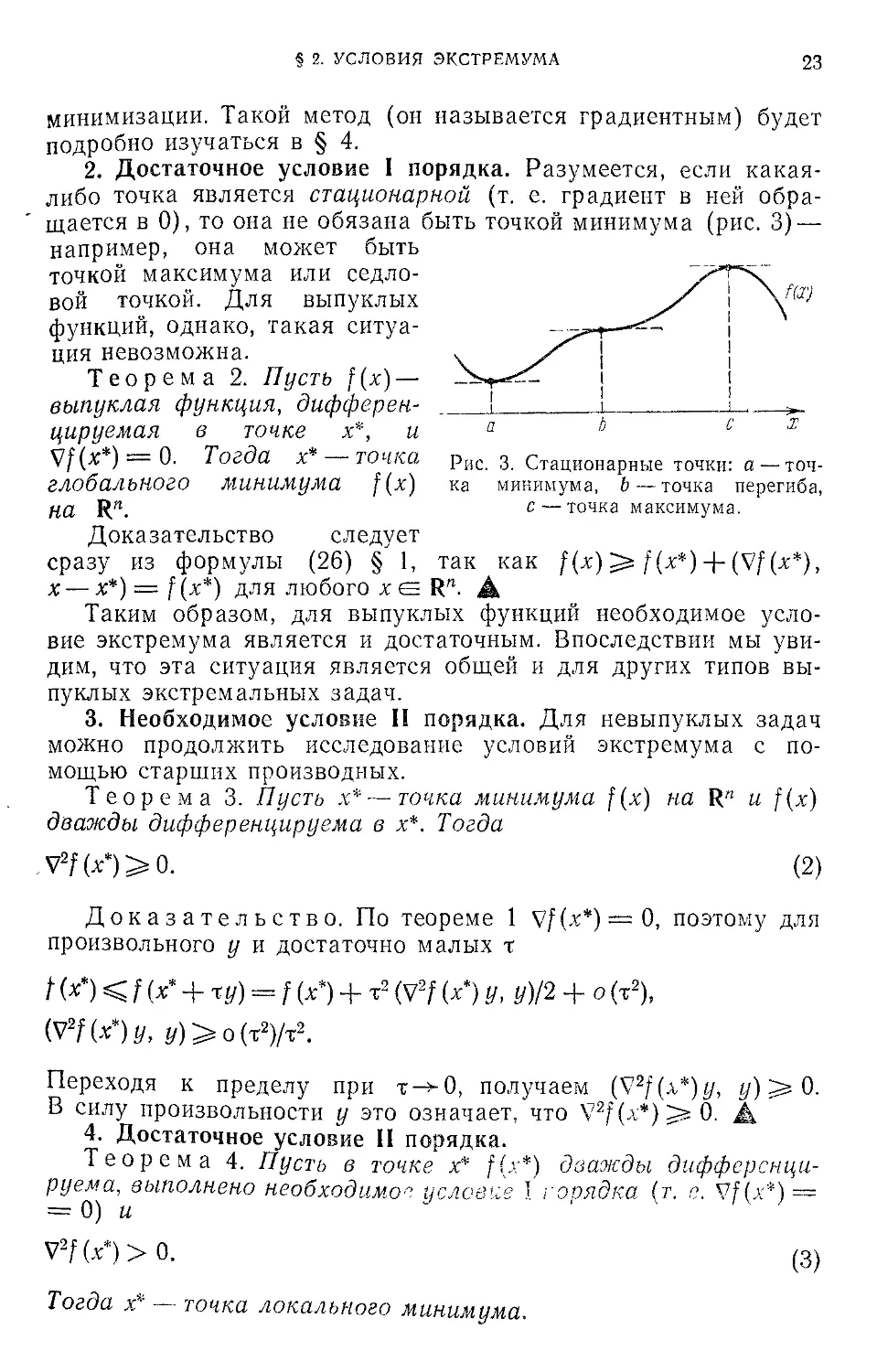

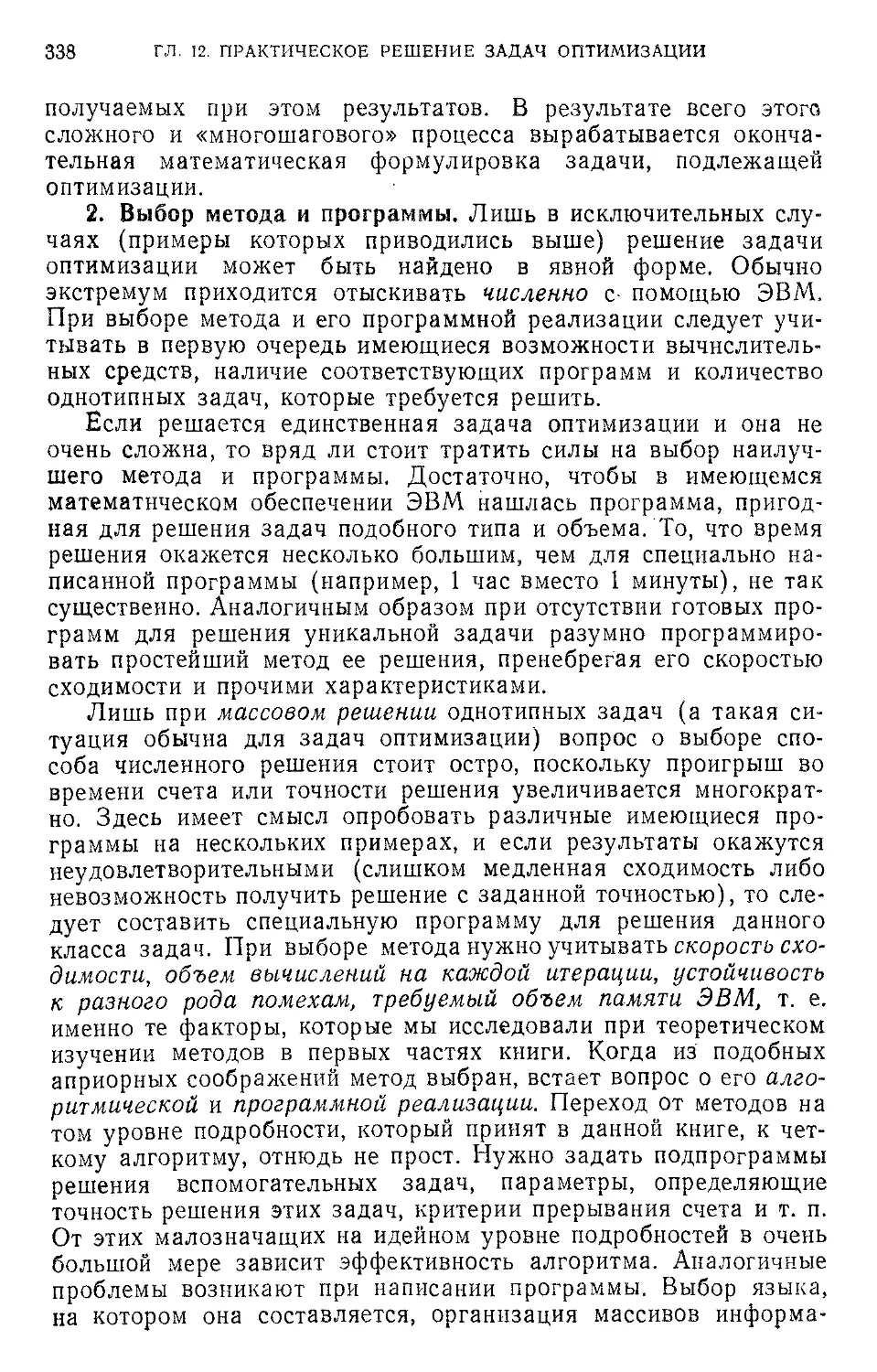

Рис. 2. Типы выпуклости: а) выпуклая функция; б) строго выпуклая функ-

ция; е) сильно выпуклая функция.

Из (26) получаем полезное неравенство

(vf (х) - Vf (у), X - у) > 0, (29)

являющееся обобщением условия монотонности производной

выпуклой функции на многомерный случай. Для строго выпук-

лой функции справедливо условие строгой монотонности

(Vf(x)-V/(H х-г/)> 0, х^у, (30)

а для сильно выпуклой — условие сильной монотонности

(yf (х) - vf (у), х - у) > /1| х - у ||2. (31)

Наиболее просто критерий выпуклости формулируется для

дважды дифференцируемых функций f(x): выпуклость эквива-

лентна выполнению условия

V2f (х) > 0, (32)

а сильная выпуклость — выполнению условия

V2/(x)>Z/ (33)

для всех х. Если же

v2f (х) > 0 (34)

для всех х, то f(x) строго выпукла. Последнее условие является

лишь достаточным (например, для строго выпуклой функции

Дх) = ||х||4 будет V2/(0)= 0)

Пусть х* точка „минимума дифференцируемой сильно вы-

пуклой (с константой /) функции /(х). Такая точка заведомо

22

ГЛ. 1. ТЕОРИЯ и МЕТОДЫ БЕЗУСЛОВНОЙ МИНИМИЗАЦИИ

существуем единственна и V/(x*) —О (см. ниже §§ 2, 3). По-

этому из неравенств (28), (31) получаем

f(x)>f(x-) + /||x-x*||2/2,

(35)

(Vf (х), х - xs) > 11| х - х* ||2, (36)

1П(х)||^/||Х-Х*||.

(37)

Упражнение.

7, Убедитесь в справедливости следующих утверждений:

а) функция (Ах, х)/2— (Ь х), А > 0 сильно выпукла;

б) функция (Ах, х)/2 — (Ь, х) с вырожденной матрицей А 2г 0 (в част-

ности, линейная функция) выпукла, но не строго выпукла;

в) функция ||х|| “ выпукла при а 2^ 1, строго-выпукла при а > 1, сильно

выпукла только при а = 2.

§ 2. Условия экстремума

Условия экстремума гладких функций на всем пространстве

хорошо известны. Мы рассмотрим их, однако, достаточно по-

дробно, так как они служат моделью, по которой строятся ана-

логичные условия в более сложных случаях.

1. Необходимое условие 1 порядка. Точка х* назы-

вается локальным- минимумом f(x) на R", если найдется е > О

такое, что f(x)^f(x*) для всех х из е-окрестности х* (т. е. при

||х— х*|| ^е). Иногда в таком случае говорят просто о точке

минимума, отбрасывая слово «локальный». Нужно, однако,

иметь в виду разницу между локальным и глобальным мини-

мумом (т. е. точкой х* такой, что )(х)Дг f(х*) для всех х). В не-

обходимых условиях экстремума можно говорить просто о точке

минимума, поскольку если некоторое условие выполняется для

локального минимума, то оно же справедливо для глобального.

При формулировке достаточных условий нужно различать, ка-

кой из типов минимума подразумевается.

Теорема 1 (Ферма). Пусть х* — точка минимума f(х) на

R” и f(x) дифференцируема в х*. Тогда

Vf(x*) = 0. (1)

Доказательство. Пусть Vf(х*) =0= 0. Тогда

f (х* - xVf (х*)) = f (х*) - т || Vf (х*) ||2 + о (Wf (х*)) =

= f (х*) - т (|| Vf (х*) ||2 + х-~'-о (т)) < f (х*)

для достаточно малых т > 0 по определению о(т). Но это про-

тиворечит тому, что х* — точка локального минимума. А

Приведенное доказательство весьма поучительно. В предпо-

ложении, что условие экстремума не выполняется, показано,

как построить точку с меньшим значением /(х). Таким обра-

зом, это доказательство указывает путь для построения метода

§ 2. УСЛОВИЯ ЭКСТРЕМУМА

23

минимизации. Такой метод (он называется градиентным) будет

подробно изучаться в § 4.

2. Достаточное условие I порядка. Разумеется, если какая-

либо точка является стационарной (т. е. градиент в ней обра-

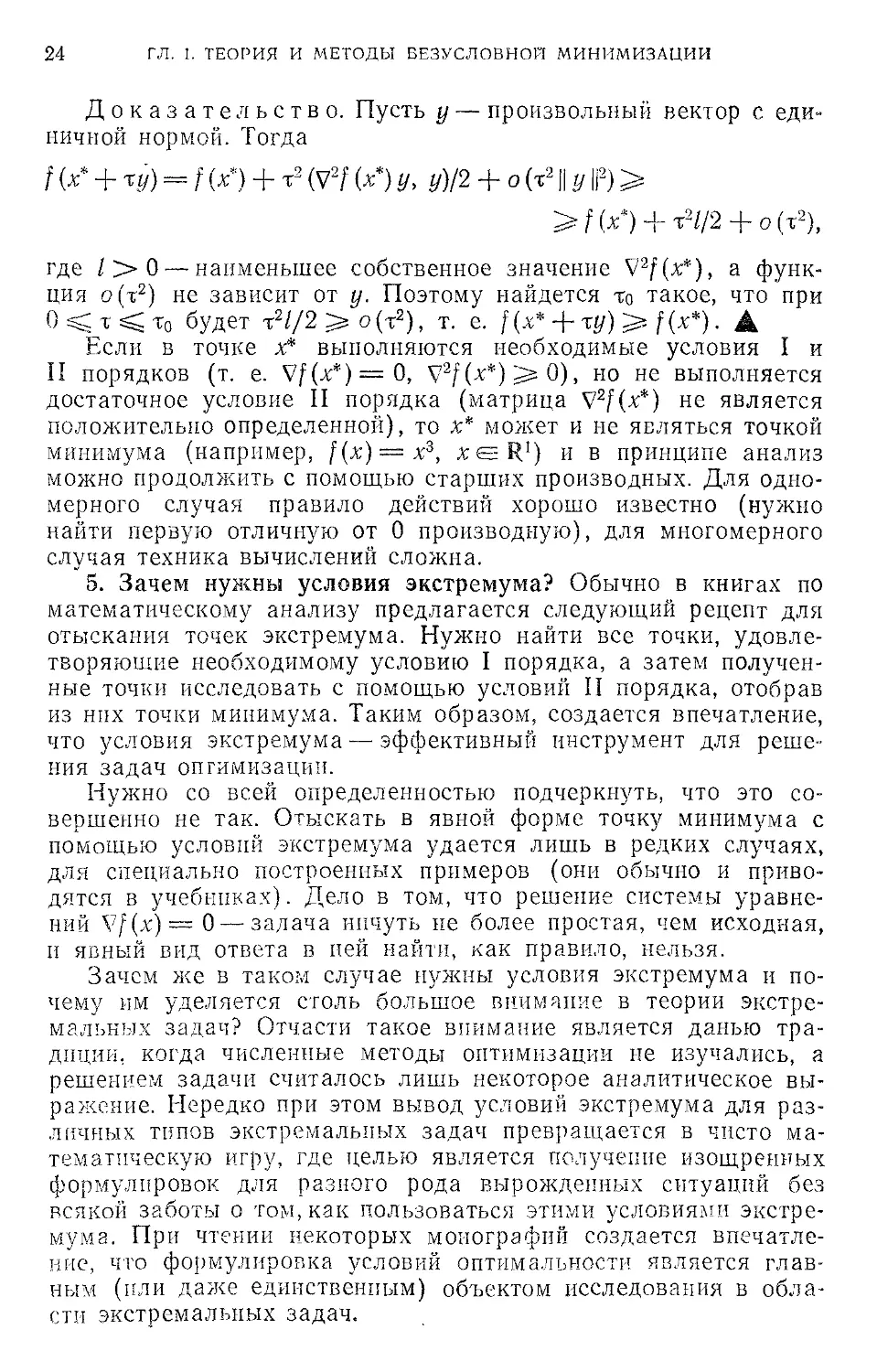

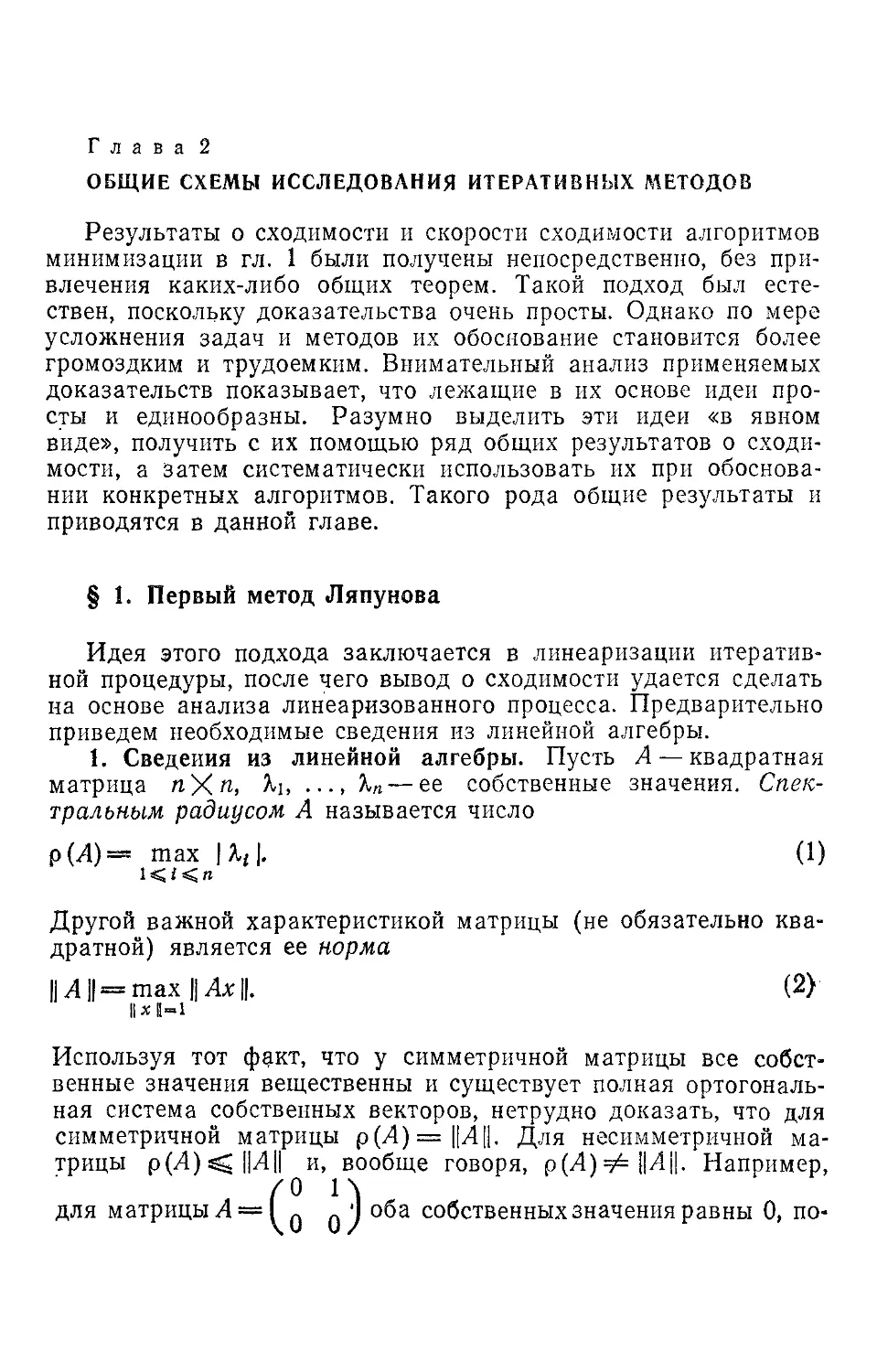

щается в 0), то она не обязана быть точкой минимума (рис. 3) —

например, она может быть

точкой максимума или седло-

вой точкой. Для выпуклых

функций, однако, такая ситуа-

ция невозможна.

Теорема 2. Пусть f(x)—

выпуклая функция, дифферен-

цируемая в точке х*, и

Vf(x*) = 0. Тогда х* точка рис 3 Стационарные точки: а — точ-

глобального минимума f(x) ка минимума, Ь — точка перегиба,

на R\ с — точка максимума.

Доказательство следует

сразу из формулы (26) § 1, так как f (х) f(x*) -ф (Vf (х*),

х — х*) = f (х*) для любого х g R". А

Таким образом, для выпуклых функций необходимое усло-

вие экстремума является и достаточным. Впоследствии мы уви-

дим, что эта ситуация является общей и для других типов вы-

пуклых экстремальных задач.

3. Необходимое условие П порядка. Для невыпуклых задач

можно продолжить исследование условий экстремума с по-

мощью старших производных.

Теорема 3. Пусть х*— точка минимума f(x) на R” и f(x)

дважды дифференцируема в х*. Тогда

. V2/ (х‘) > 0. (2)

Доказательство. По теореме 1 Vf(x*) = 0, поэтому для

произвольного у и достаточно малых т

t (**) С Их* + ху) = f (X*) + т2 (V2/ (х*) у, у)/2 + о (т2),

(W)!/, г/)>о(т2)/т2.

Переходя к пределу при т->0, получаем (V2f(x*)y, у) Д 0.

В силу произвольности у это означает, что V2f(x*)J=: 0- А

4. Достаточное условие II порядка.

Теорема 4. Пусть в точке х* )(х*) дважды дифференци-

руема, выполнено необходимое условие I гооядка (т. е.

= 0) и

Ш>о. (3)

Тогда х" точка локального минимума.

24

ГЛ. 1. ТЕОРИЯ И МЕТОДЫ БЕЗУСЛОВНОЙ МИНИМИЗАЦИИ

Доказательство. Пусть у — произвольный вектор с еди-

ничной нормой. Тогда

f (х* + ту) = f (х*) + т2 (V2/' (х*) у, у)/2 + о (т21| у ||2) >

> f (х*) + т2//2 + о (т2),

где I > 0 — наименьшее собственное значение V2f(x*), а функ-

ция о(т2) не зависит от у. Поэтому найдется то такое, что при

О т т0 будет т2//2 о (т2), т. е. f (х* + ту) f (х*). А

Если в точке х* выполняются необходимые условия I и

II порядков (т. е. Vf(x*) = O, V2f (х*) 0), но не выполняется

достаточное условие II порядка (матрица V2f(x*) не является

положительно определенной), то х* может и не являться точкой

минимума (например, )(х) = х3, xsR’l и в принципе анализ

можно продолжить с помощью старших производных. Для одно-

мерного случая правило действий хорошо известно (нужно

найти первую отличную от 0 производную), для многомерного

случая техника вычислений сложна.

5. Зачем нужны условия экстремума? Обычно в книгах по

математическому анализу предлагается следующий рецепт для

отыскания точек экстремума. Нужно найти все точки, удовле-

творяющие необходимому условию I порядка, а затем получен-

ные точки исследовать с помощью условий II порядка, отобрав

из них точки минимума. Таким образом, создается впечатление,

что условия экстремума — эффективный инструмент для реше-

ния задач оптимизации.

Нужно со всей определенностью подчеркнуть, что это со-

вершенно не так. Отыскать в явной форме точку минимума с

помощью условий экстремума удается лишь в редких случаях,

для специально построенных примеров (они обычно и приво-

дятся в учебниках). Дело в том, что решение системы уравне-

ний Vf(x) = 0 — задача ничуть не более простая, чем исходная,

и явный вид ответа в пей найти, как правило, нельзя.

Зачем же в таком случае нужны условия экстремума и по-

чему им уделяется столь большое внимание в теории экстре-

мальных задач? Отчасти такое внимание является данью тра-

диции, когда численные методы оптимизации не изучались, а

решением задачи считалось лишь некоторое аналитическое вы-

ражение. Нередко при этом вывод условий экстремума для раз-

личных типов экстремальных задач превращается в чисто ма-

тематическую игру, где целью является получение изощренных

формулировок для разного рода вырожденных ситуаций без

всякой заботы о том, как пользоваться этими условиями экстре-

мума. При чтении некоторых монографий создается впечатле-

ние, что формулировка условий оптимальности является глав-

ным (пли даже единственным) объектом исследования в обла-

сти экстремальных задач.

§ 3. СУЩЕСТВОВАНИЕ, ЕДИНСТВЕННОСТЬ, УСТОЙЧИВОСТЬ

25

На наш взгляд условия экстремума являются той основой,

на которой строятся методы решения оптимизационных задач,—

с этой точки зрения и нужно рассматривать вопрос о их полез-

ности. В дальнейшем мы увидим, что, во-первых, в ряде случаев

условия экстремума хотя и не дают возможности явно найти

решение, но сообщают много информации о его свойствах. Во-

вторых, доказательство условий экстремума или вид этих усло-

вий часто указывают путь построения методов оптимизации. Мы

уже видели выше, что доказательство условия yf(x*) = 0 есте-

ственно приводит к градиентному методу минимизации.

В-третьих, при обосновании методов приходится делать ряд

предположений. Обычно при этом требуется, чтобы в точке х*

выполнялось достаточное условие экстремума. Таким образом,

условия экстремума фигурируют в теоремах о сходимости ме-

тодов. Наконец, сами доказательства сходимости обычно стро-

ятся на том, что показывается, как «невязка» в условии экстре-

мума стремится к нулю. У читателя будет в дальнейшем много

поводов убедиться в полезности условий экстремума.

§ 3. Существование, единственность, устойчивость минимума

Важной частью математической теории экстремальных задач

(и в частности, задач безусловной оптимизации) являются проб-

лемы существования, единственности и устойчивости решения.

1. Существование решения. Вопрос о существовании точки

минимума обычно решается совсем просто с помощью следую-

щей теоремы.

Теорема 1 (Вейерштрасс). Пусть f(x) непрерывна на R"

и множество Qa= {х: f(x)^a} для некоторого а непусто и

ограничено. Тогда существует точка глобального минимума

f(x) на Rn. <

Доказательство. Пусть f(xft)->inf f(х) > а, тогда хк е

хе Rra

е Qa Для достаточно больших k. Множество Qa замкнуто

(в силу непрерывности f(x)) и ограничено, т. е. компактно, а

потому у последовательности хк существует предельная точка

х* е Qa. Из непрерывности f(x) следует, что f(x*)~ inf f(x),

т. e. x* = argmin f(x). A

Предположение об ограниченности Qa существенно (напри-

мер, функции х и 1/(1 -ф х2) непрерывны на R1, но не имеют

точки минимума). В некоторых случаях можно доказать су-

ществование решения и в ситуациях, не охватываемых теоре-

мой 1 (см. ниже упр. 2).

Упражнения.

стиг^т^™аЖИТе’ Д° диФФеРенциРУемая сильно выпуклая функция на R"’ до-

стигает минимума (воспользуйтесь неравенством (28) § 1 и теоремой 1).

26

ГЛ. 1, ТЕОРИЯ и МЕТОДЫ БЕЗУСЛОВНОЙ МИНИМИЗАЦИИ

2. Пусть f(x) —г(Ах, х) — (&, %), А>0 и f(x) ограничена снизу (напри-

мер, Щх) =- \\Вх — d||2). Докажите, что f(x) достигает минимума на R,!, хотя

условия теоремы 1, вообще говоря, не выполняются (множество Qa не обя-

зательно ограничено).

2. Единственность решения. Будем называть точку минимума

локально единственной, если в некоторой ее окрестности нет

других локальных минимумов. Будем говорить, что х* — невы-

рожденная тонка минимума, если в ней выполнено достаточное

условие экстремума II порядка, т. е. у/(х*) = 0, V2f(x*)> 0.

Теорема 2. Невырожденная точка минимума локально

единственна.

Доказательство. В соответствии с упражнением 6 § 1

Vf(x) — Vf(x*)+ V2f(x*) (х— х*) + о (х — х*), поэтому ||Vf(x)|| —

— ilV2f(x*) (х —X*) II + о(||х—- х*||) 1\\х-- Х*|| 4-0 (||х — х*||) >0

для достаточно малых ||х — х*|1, поскольку при V2/(х*) = А > О

имеем ||4х|| /||х|| для всех х, где /> 0 — наименьшее соб-

ственное значение А. Таким образом, в некоторой окрестности

х* нет стационарных точек f(x), а значит, и точек минимума. А

Для выпуклых функций ответ на вопрос об единственности

минимума часто может быть получен совсем просто.

Теорема 3. Точка минимума строго выпуклой функции

(глобально) единственна.

Доказательство следует непосредственно из определения

строгой выпуклости. А

3. Устойчивость решения. При практическом решении задач

оптимизации постоянно приходится сталкиваться со следую-

щими проблемами. Пусть метод оптимизации приводит к по-

строению минимизирующей последовательности, следует ли от-

сюда ее сходимость к решению? Если вместо исходной задачи

минимизации решается задача, близкая к ней, можно ли

утверждать близость их решений? Такого типа проблемы отно-

сятся к области теории экстремальных задач, связанной с по-

нятиями устойчивости и корректности. Мы будем пользоваться

термином «устойчивость» задач оптимизации, оставляя термин

«корректность» для задач, не связанных с оптимизацией (ре-

шение алгебраических, интегральных, операторных уравнений

и т. п.).

Точка х* локального минимума f(x) называется локально

устойчивой, если к ней сходится любая локальная минимизи-

рующая последовательность, т. е. если найдется 6 > 0 такое,

что из f(xfe)->f(х*), \\xk— х*[| гС б следует хй->х*.

Теорема 4. Точка локального минимума непрерывной

функции f(x) локально устойчива тогда и только тогда, когда

она локально единственна.

Доказательство. Пусть х* локально единственна. Возь-

мем произвольную локальную минимизирующую последова-

тельность xk, ||xfe —x*||C6, f(xk)-^f(x*). В силу компактности

§ 3 СУЩЕСТВОВАНИЕ, ЕДИНСТВЕННОСТЬ, УСТОЙЧИВОСТЬ 27

щара в R" из нее можно выбрать сходящуюся подпоследователь-

ность xki~>x, ||х — х*|| С 5- Из непрерывности f (х) следует, что

= litnf(xfe<) = f(x*), но тогда х = х* (так как х* локально

единственная точка минимума). Поскольку это же верно для

любой другой подпоследовательности, то и вся последователь-

ность хк сходится к х*. Таким образом, к* локально устойчива.

Обратно, пусть х* локально устойчива, но существует другая

точка минимума х] =г= х, || х\ — х* || 6. Тогда f (xi) = f (х*). Возь-

мем последовательность точек х1, х2, ..., поочередно совпадаю-

щих то с х*. то с xt Она является минимизирующей, но не схо-

дится, что противоречит локальной устойчивости х*. А

Аналогично доказывается следующий результат.

Теорема 5. Пусть х* — локально устойчивая точка мини-

мума непрерывной функции f (х), a g(x) — непрерывная функ-

ция. Тогда для достаточно малых е>0 функция f(x)-|-eg(x)

имеет локально единственную точку минимума хв в окрестности

х* и хе->х* при е->0. Д

Таким образом, из устойчивости следует близость точек ми-

нимума исходной и «возмущенной» функции.

Невырожденная точка минимума, как следует из теорем 2

и 4, является локально устойчивой. В этом случае результат

теоремы 5 можно уточнить.

Теорема 6. Пусть х*—-невырожденная точка минимума

f(x), а функция g(x) непрерывно дифференцируема в окрест-

ности х*. Тогда для достаточно малых s > 0 существует хЕ—

локальная точка минимума функции f (х) -|- eg(x) в окрестности

х*, причем

xe = x*-e[V2f(x*)]“1V^(x*) + o(e). А (1)

Можно ввести и глобальное понятие устойчивости точек ми-

нимума. Для этого нужно в определении слово «локальный»

заменить на «глобальный». Именно, точка глобального мини-

мума называется глобально устойчивой, если к ней сходится

любая минимизирующая последовательность. Будем в этом слу-

чае говорить о глобальной устойчивости задачи минимизации.

Повторяя почти дословно доказательство теоремы 4, получаем,

что если ^х*— единственная точка глобального минимума не-

прерывной функции f(x) и множество Qa = {х: /(x)s^a} не-

пусто и ограничено для некоторого a>f(x*), то х* глобально

устойчива. Требование ограниченности существенно. Напри-

мер, у функции Дх) =: х2/(1 ф-х4), xeR1, точка глобального

минимума х* = 0 единственна, но не глобально устойчива (так

как минимизирующая последовательность xfe—>оо не сходится

к X*).

Можно было бы ввести следующее более широкое опреде-

ление устойчивости, которое не предполагает единственности

минимума. Множество А* точек глобального минимума f(x),

28

ГЛ. t. ТЕОРИЯ И МЕТОДЫ БЕЗУСЛОВНОЙ МИНИМИЗАЦИИ

назовем слабо устойчивым, если все предельные точки любой

минимизирующей последовательности принадлежат X*. Крите-

рий слабой устойчивости указан в упражнении 5.

Помимо качественной характеристики (устойчива или нет

точка минимума), важно иметь количественные оценки устой-

чивости. Такие оценки, позволяющие судить о близости точки

х к решению х*, если f(x) близко к f(x*), уже были получены

ранее для сильно выпуклых функций. Именно, из (35) § 1 по-

лучаем

|| х - х* ||2 < 2Г1 (f (х) - f (х*)), (2)

где I — константа сильной выпуклости. Аналогичная локальная

оценка справедлива для невырожденной точки минимума:

II х - х* |р < 2Г1 (f (х) - f (х*)) + о (f(x) - f (х*)), (3)

где I — наименьшее собственное значение матрицы V2/(x*).

Таким образом, число I характеризует «запас устойчивости»

точки минимума. Оно, однако, не всегда удобно как мера устой-

чивости— например, оно меняется при умножении f(x) па кон-

станту. Поэтому часто используют следующий «нормирован-

ный» показатель. Назовем обусловленностью точки минимума

х* число

р, = lim ( sup || х — х* ||2/ inf || х — х* ||2),

«->0 xelj (4)

—{х: f(x) = f(x*) + 6}.

Иначе говоря, it характеризует степень вытянутости линий

уровня /(х) в окрестности х*. Ясно, что всегда ц 1. Если ц

велико, то линии уровня сильно вытянуты—функция имеет

овражный характер, т. е. резко возрастает по одним направле-

ниям и слабо меняется по другим. В таких случаях говорят о

плохо обусловленных задачах минимизации. Если же ц близко

к 1, то линии уровня /(х) близки к сферам; это соответствует

хорошо обусловленным задачам. В дальнейшем мы увидим, что

число обусловленности ц возникает во многих проблемах, свя-

занных с безусловной минимизацией, и может служить одним

из показателей сложности задачи.

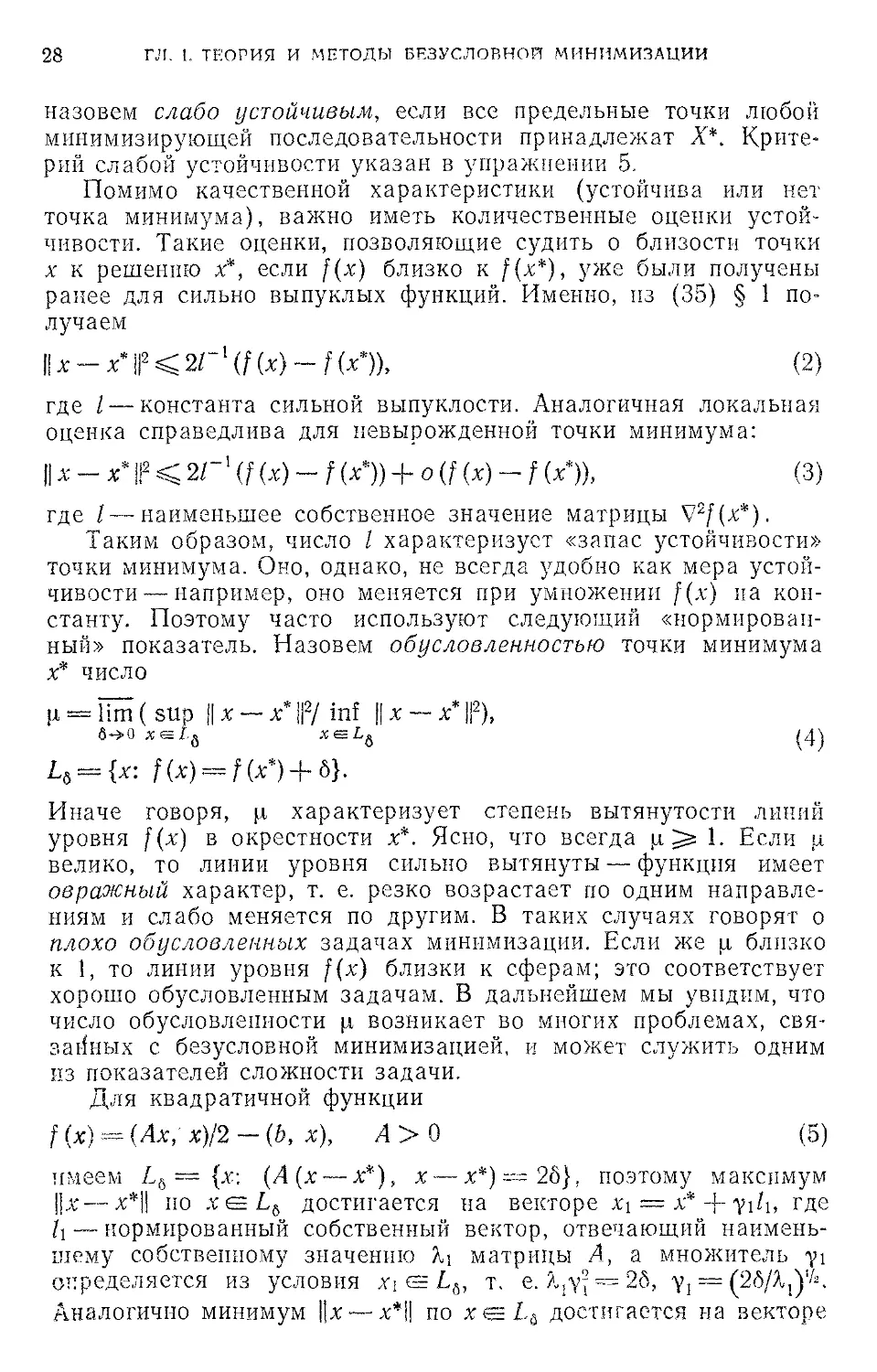

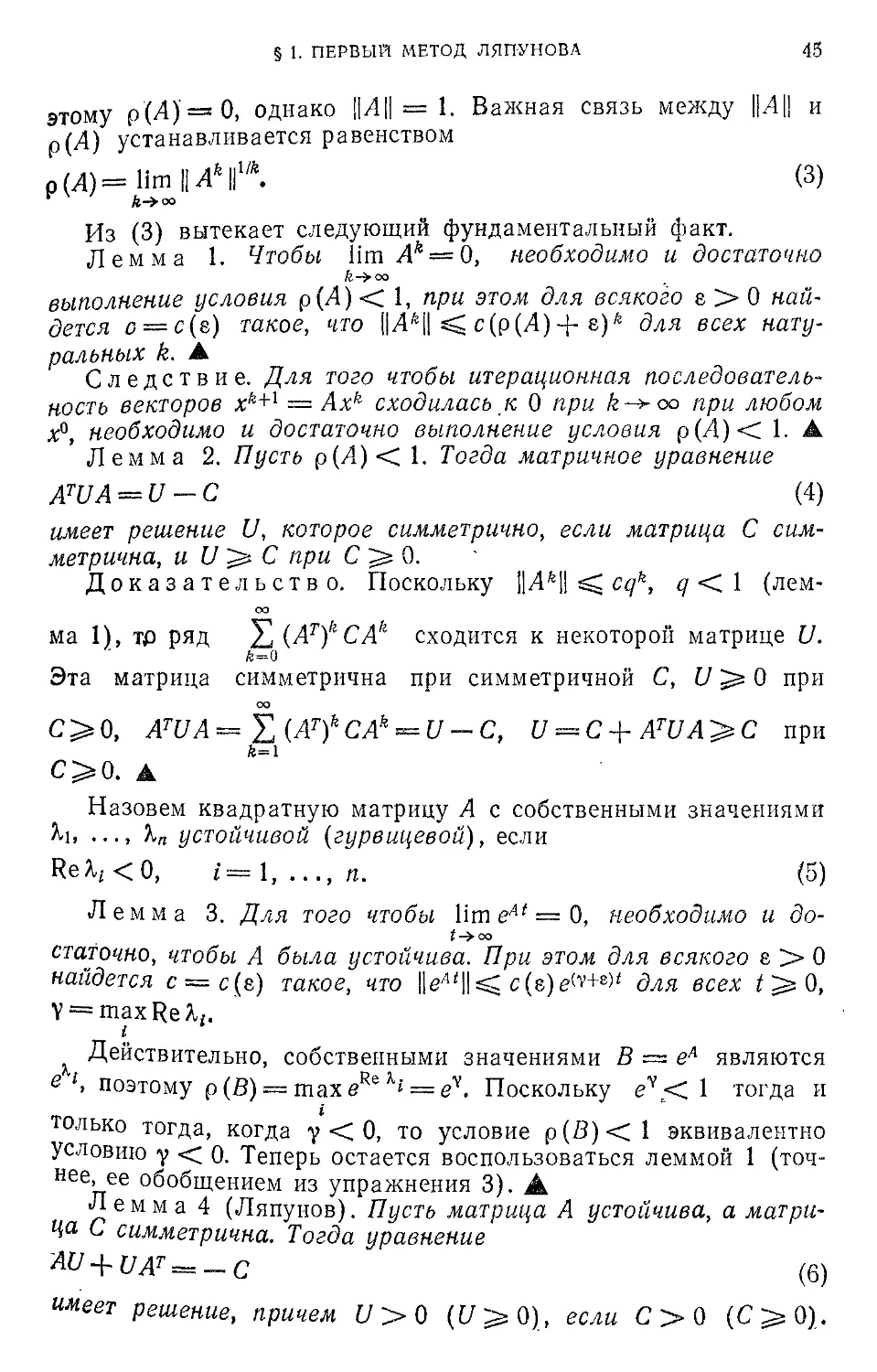

Для квадратичной функции

f (х) ==- (Ах, х)/2 - (Ь, х), А > 0 (5)

имеем А6 — {х: (А(х-—х*), х — х*)=26}, поэтому максимум

||х— х*|| по достигается на векторе xi = x* + yi/i, где

?! — нормированный собственный вектор, отвечающий наимень-

шему собственному значению Zi матрицы А, а множитель р

определяется из условия xi ез L&, т. е. = у! = (26/%^.

Аналогично минимум ||х—-х*|| по хе£а достигается на векторе

§ 4. ГРАДИЕНТНЫЙ МЕТОД

29

хп = х* +'ynln, In — собственный вектор, отвечающий наиболь-

шему собственному значению кп, уп — (26/Л.„)/2 (рис. 4). Таким

образом, отношение ц (6) == I] лд — ** ||2/|| хп “ х* If = Vi/Y^ =

фактически не зависит от 6 и

Заметим, что отношение наибольшего к наименьшему собствен-

ному значению называется в линейной алгебре числом обуслов-

ленности матрицы.

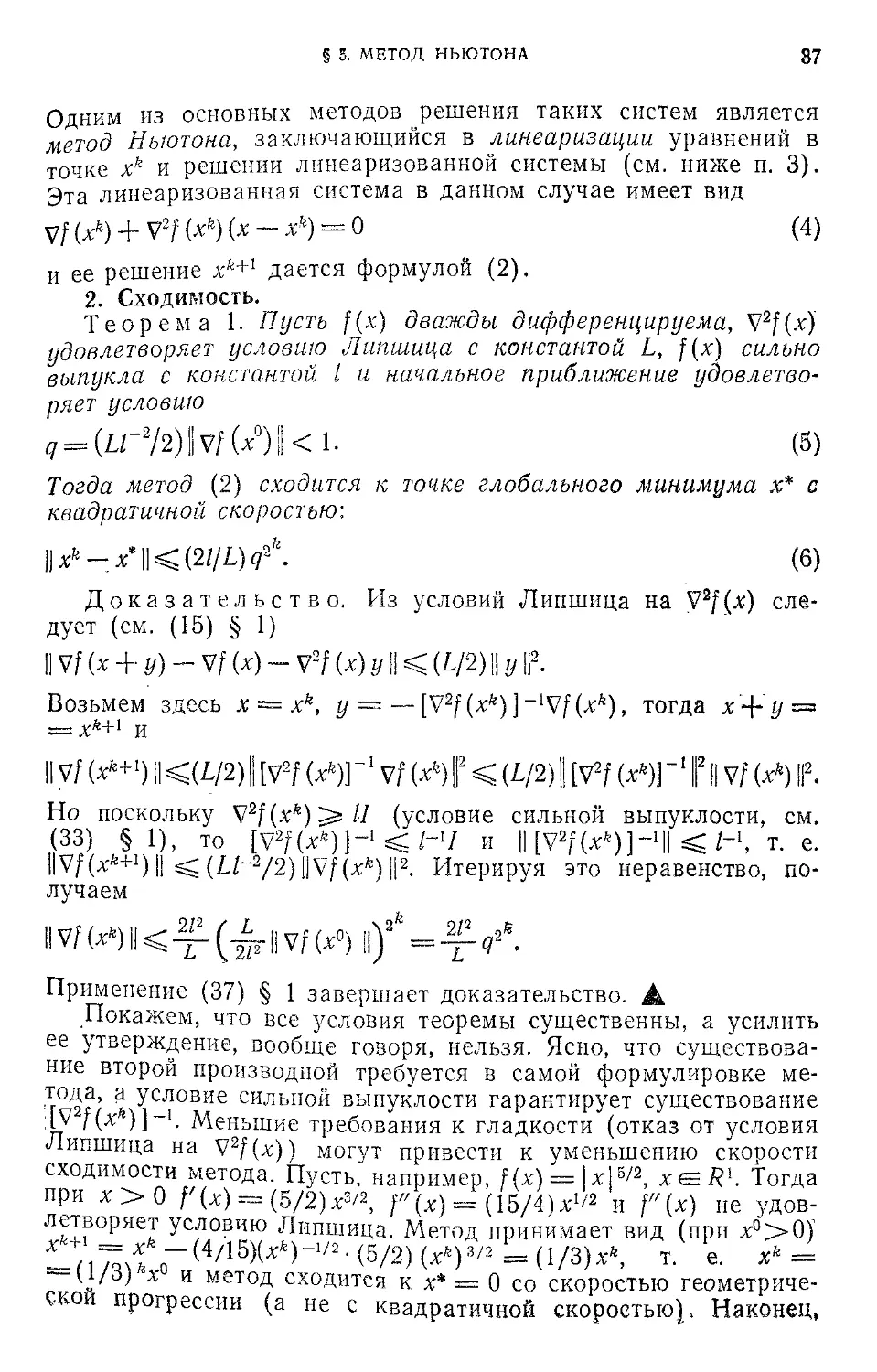

Для случая неквад-

ратичной функции обу-

словленность задачи

ее минимизации рав-

на числу обусловлен-

ности гессиана в точ-

ке минимума. Именно,

если х*— невырожден-

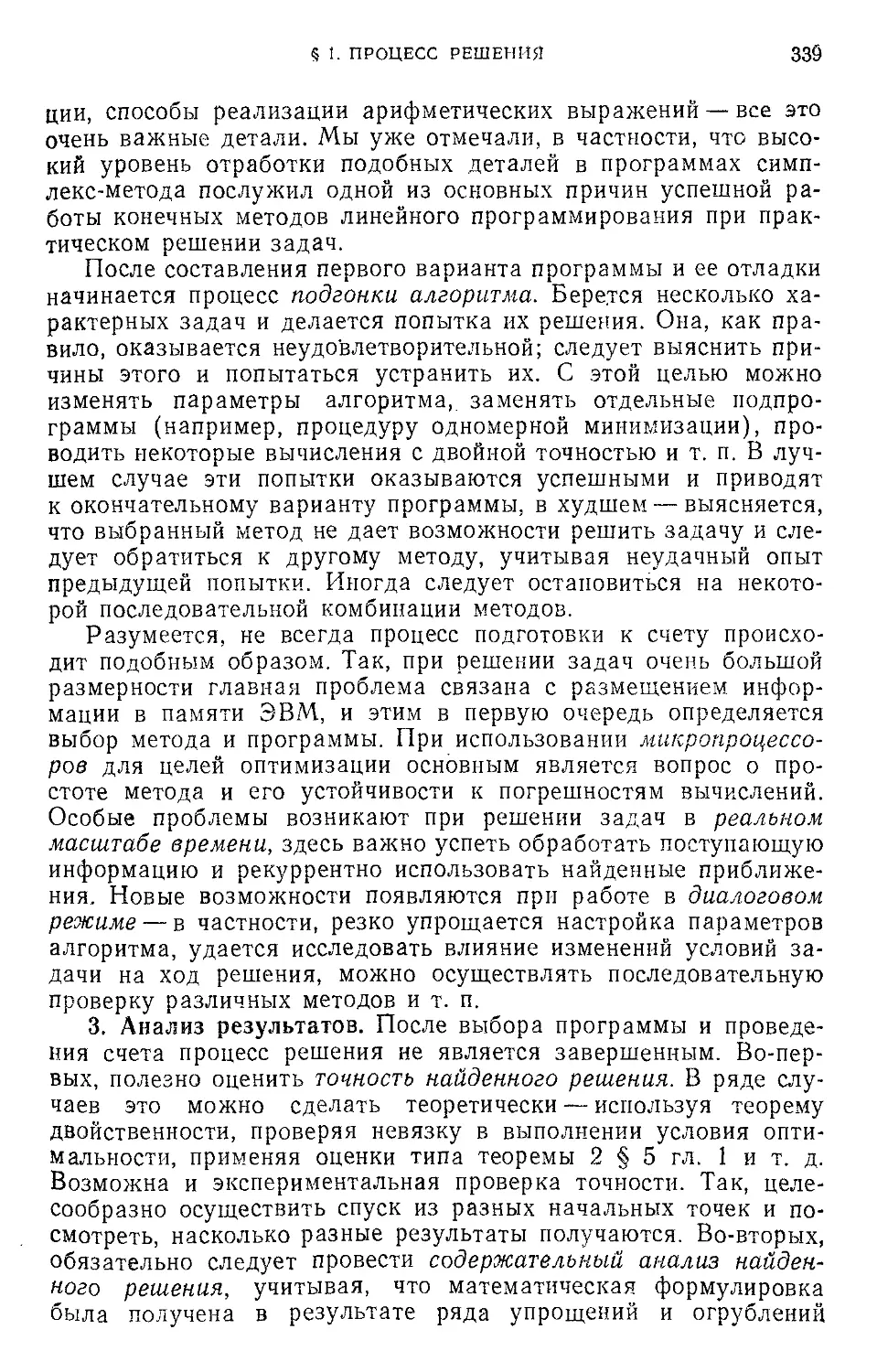

Рис. 4. Обусловленность квадратичной функ-

ции.

ная точка минимума,

то

L

[Л z ,

(7)

где L — наибольшее, а I — наименьшее собственное значение

матрицы V2f(x*).

Мы увидим в дальнейшем, что в практических приложениях

часто возникают неустойчивые или плохо обусловленные задачи

оптимизации. Обсуждение методов их решения будет дано в § 1

гл. 6.

Упражнения.

3. Покажите, что точка минимума строго выпуклой непрерывной функции

глобально устойчива.

4. Проверьте, что в условиях упражнения 2 множество точек минимума

слабо устойчиво.

5. Докажите, что если /(х) непрерывна и = {х-. f(x) а} непусто и

ограничено для некоторого а > inf f(x), то множество точек минимума f(x)

слабо устойчиво.

6. Покажите, что обусловленность задачи не меняется при монотонных

преобразованиях функции и ортогональных преобразованиях переменных, т. е.

обусловленность f(x) и f (х) = одинакова, если <р: R’ -> R1 моно-

тонно возрастающая непрерывная функция, a U — ортогональная матрица.

7. Убедитесь, что для функции f (х) = Х[ -{- х? в R обусловленность точки

минимума равна бесконечности.

8. Докажите, что для дифференцируемой функции f(x) не может выпол-

няться неравенство f(x) — а||х~ х*||. сг'> О

§ 4. Градиентный метод

1. Эвристические соображения. Мы переходим к анализу наи-

олее важных в идейном отношении методов безусловной ми-

нимизации градиентного и Ньютона. Эти методы, редко

30

ГЛ. 1 ТЕОРИЯ И МЕТОДЫ БЕЗУСЛОВНОЙ МИНИМИЗАЦИИ

применяемые на практике в «чистом виде», служат моделью для

построения более реалистических алгоритмов. На примере дан-

ных методов будет подробно разобран вопрос о сходимости —

будут даны различные доказательства сходимости, описана

общая техника построения доказательств, обсуждены соотно-

шения между теоретическими результатами о сходимости и

практическим использованием методов.

Предположим, что в любой точке х можно вычислить гра-

диент функции Vf(x). В такой ситуации наиболее простым ме-

тодом минимизации f(x) является градиентный, в котором, на-

чиная с некоторого начального приближения х°, строится ите-

рационная последовательность

xfe+‘ = xk — ykVf(xk), (1)

где параметр у* 0 задает длину шага. К методу (1) можно

прийти из разных соображений.

Во-первых, при доказательстве необходимых условий экстре-

мума (теорема 1 § 2) мы использовали то обстоятельство, что

если в точке х условие экстремума не выполняется (Vf(x)=H= 0),

то значение функции можно уменьшить, перейдя к точке

х — xVf(x) при достаточно малом т > 0. Итеративно применяя

этот прием, приходим к методу (1).

Во-вторых, в точке хк дифференцируемая функция f(x) при-

ближается линейной fk(x) — f(xk) + (Vf(xfe), x — xk) с точно-

стью до членов порядка о(х — xk). Поэтому можно искать ми-

нимум аппроксимации /Т(х) в окрестности хк. Например, можно

задаться некоторым е* и решить вспомогательную задачу

min fk (х). (2)

|| x-xk II < ей

Ее решение естественно принять за новое приближение xft+‘.

Можно остаться в окрестности хк и иначе, добавив к fk(x)

«штраф» за отклонение от хк. Например, можно решить вспомо-

гательную задачу

min [fk(x) + afe||x — xft ||2] (3)

и ее решение взять в качестве xft+1. Читателю предоставляется

убедиться в том, что решение задач (2), (3) задается форму-

лой (1).

В-третьих, можно в точке хк выбрать направление локаль-

ного наискорейшего спуска, т. е. то направление yk, ||yfe|| = 1,

для которого достигается минимум f(xA; у). Используя фор-

мулу (6) из § 1 для производной по направлению, получаем

/ = argrnin (V/ (Xй), у) = — Vf (xfe)/|| Vf (xfe) ||. (4)

nii=i

Таким образом, направление наискорейшего спуска проти-

воположно направлению градиента.

§ 4. ГРАДИЕНТНЫЙ МЕТОД

31

Мы привели здесь столь подробно эти соображения, по-

скольку они же будут использоваться при построении методов

оптимизации в более сложных ситуациях (например, при нали-

чии ограничений). Однако в этих ситуациях они могут привести

к различным методам.

2. Сходимость. Рассмотрим простейший вариант градиентно-

го метода, в котором yk s у:

xk+i = xk — yvf(xk'). (5)

Нас будет интересовать поведение этого метода при различных

предположениях относительно f(x) и у.

Теорема 1. Пусть f(x) дифференцируема на R", градиент

f(x) удовлетворяет условию Липшица-.

|| xjf (х) - Vf (</) II < L || х - у ||, (6)

f(x) ограничена снизу:

f (х) > f > — оо (7)

и у удовлетворяет условию

О < у < ЦЬ. (8)

Тогда в методе (5) градиент стремится к 0:

lim V/ (xft) = 0,

fe->oo

а функция f(x) монотонно убывает: f (х^1) f (х^).

Доказательство. Подставим в формулу (8) § 1 х = xk,

У——y^fix11) и воспользуемся (6):

f (xft+1) = f (xk) — у II Vf (xk) II2 — V (Vf (xk ” M’Vf (xk)) —

- Vf (xk), (xfe)) dx < f (x*) — Y II Vf (xft) ||2 +

+ Ay2 II Vf (xfe) ||2 J т dx = f (xfe) - у (1 - | Ay) II Vf (xfe) ||2.

0

Суммируя неравенства

f(xfe+1)<f(x^)— a||vf (xfe) If2, а = у(1-Ау/2) (9)

no k от 0 до s, получаем

f(xs+1)<Hxn)-af || Vf (xfe)||2.

fe=0

32

ГЛ. 1. ТЕОРИЯ И .МЕТОДЫ БЕЗУСЛОВНОЙ МИНИМИЗАЦИИ

Поскольку а>0 в силу (8), то

I II Vf (хй) ||2 Д а-> (f (,Д) - f (V+1)) <a"1 (f ('Л ~ П

k- Н)

при всех s, т. е. Е II Vf (х':) j)2 < сю. Отсюда || V/ (хк) || -> 0. ▲

k=- о

Покажем, что все условия этой теоремы существенны. Нару-

шения условия (6) могут быть двух типов. Во-первых, функция

f(x) может быть недостаточно гладкой в какой-либо точке.

Пусть, например, )(х) = ||х||!+“, 0<а<1. Эта функция диф-

ференцируема, но ее градиент не удовлетворяет условию Лип-

шица, так как l|V/r(x) — Vf(O)||/j|x—0|| = (ос -f- 1) ЦхЦ01-1 —оо при

||х|| -> 0. В этом случае будет у||V/(xft) || > ||xft — х*|| = ||х*|| при

малых ||х&||, т. е. шаг в методе (5) получается большим и моно

тонкость убывания f(x) нарушается. Во-вторых, (6) не выпол-

няется для функций, растущих быстрее квадратичной. Пусть,

например, Дх) = ||х||2+а, ос > 0, тогда ||V/(x) — Vf(O) ||/||х — 0|| =

= (2 -4- ос) ||х||а—> оо при |1х|| -->оо. При этом для всякого у>0

можно указать такое х°, что метод (5), примененный к функции

||х||2+«, а > 0, с начальным приближением х°, расходится, по-

скольку будет ||х&+!|| > ||х&||, k = 0, 1, ...

Если не выполнено условие (7), то функция f(x) не дости-

гает минимума и градиент в методе (5) не обязан стремиться

к 0 (например, если Дх) линейна: f(x) = (c, х), то ||Vf(x)||s=

= 1И1> 0).

Наконец, выбирать у, нарушая условие (8), вообще говоря,

также нельзя, что видно на примере функции Дх) = Lx2/2,

х е R1. Действительно, если у ^з 2/L, то в методе (5) для

этой функции будет Дх/с+!) Дз f (xft), k = 0, 1, ..., при лю-

бом х°.

С другой стороны, при сделанных в теореме 1 предположе-

ниях нельзя доказать ничего большего, например, сходимость

последовательности xk. Примером может служить Дх) = 1/(1 4-

4-||х||2). Эта функция удовлетгюряет условиям теоремы и при

любом х° 0 будет ||хй||—>-оо.

Если потребовать, чтобы множество {х: Дх)^Дх0)} быль

ограничено, то из xft можно выбрать подпоследовательность,

сходящуюся к некоторой стационарной точке х*. Однако точка

х* не обязана быть точкой локального или глобального мини-

мума. В частности, градиентный метод (5) (или даже (1) с про-

извольным выбором у.Д, начатый из некоторой стационарной

точки х°, останется в этой точке: хк — х° для всех /г. Иными

словами, градиентный метод «застревает» в любой стационар-

ной точке — точке максимума, минимума или седловой. Что же

касается поиска глобального минимума, то градиентный метод

«не отличает» точед локального минимума от глобального и

§ 4. ГРАДИЕНТНЫЙ метод

83

никакой гарантии сходимости к глобальному минимуму он не

дает.

Наконец, в условиях теоремы 1 скорость сходимости

Vf(xk) к 0 может быть очень медленной. Например, для

f(x) = 1/х при х^ 1 (вид f(x) при х< 1 безразличен) метод

(5) при у = 1, х° = 1 принимает вид хк^ = xk (xft)-2, при

этом можно показать (используя лемму 6 § 2 гл. 2), что

|Г(?)|=0(Н/з).

Рассмотрим поведение градиентного метода для более уз-

кого класса• функций— сильно выпуклых. Естественно, здесь

удается доказать более сильные результаты, чем в теореме 1 —

именно, сходимость итераций хк к точке глобального минимума

со скоростью геометрической прогрессии.

Нам понадобится несколько неравенств, относящихся к диф-

ференцируемым, выпуклым и сильно выпуклым функциям.

Лемма 1. Пусть f(x) дифференцируема, \ф(х) удовлетво-

ряет условию Липшица с константой hu f(x)^ f* для всех х.

Тогда

|| Vf (х) ||2 2L (f (х) —- Г). (Ю)

Доказательство. Сделаем из точки х шаг градиентного

метода с у = 1/L. Тогда (см. (9))

f‘ < f (х - L-’vf (х)) < f (х) - (2L)-‘ || Vf (х) ||2. А

Лемма 2. Пусть f(x) выпукла и дифференцируема, a Vf(x)

удовлетворяет условию Липшица с константой L. Тогда

W(х) - Vf (у), x-y)^L-l\\^f (х) - Vf (У) II2. (Н)

Доказательство. Докажем (11) лишь для дважды диф-

ференцируемых функций. Тогда (см. (13) § 1)

1

Vf (У) = Vf (х) + J V2f (х -ф т (у - х)) (у - х) dx = Vf (х) 4- А (у - х),

о

1

где матрица А — (х + т {у -- х)) dr симметрична и неотри-

о

цательно определена в силу (32) § 1, т. е. Л^О. Кроме того,

||Л|| L, так как ||V2f(x)|| L для всех х в силу условия Лип-

шица на градиент. Поэтому

(Vf (х) — Vf (у), х — у) —

' = (Д (х - у), х - //)>|| А |Г' || А (х - z/)|f^ || Vf (х) - vf М-

34

ГЛ. 1. ТЕОРИЯ И МЕТОДЫ БЕЗУСЛОВНОЙ МИНИМИЗАЦИИ

Лемма 3. Пусть f(x) — дифференцируемая сильно выпук-

лая (с константой I) функция, х* — ее точка минимума (она

существует, см. упр. 1 § 3). Тогда

||Vf(x)||2>2Z(f(x)-f(x*)). А

Теорема 2. Пусть Цх) дифференцируема на Rn, ее гра-

диент удовлетворяет условию Липшица с константой L и f(x)

является сильно выпуклой функцией с константой I. Тогда при

О < у < 2/L метод (5) сходится к единственной точке глобаль-

ного минимума х* со скоростью геометрической прогрессии:

|| х* - х* || < с?, 0<<7<1.

(12)

Доказательство. Выполнены все условия теоремы 1, по-

этому справедливо неравенство (9):

f (х*+>) < f (х*) - у (1 - Ly/2) !J Vf (xft) ||2.

Используем лемму 3:

f (х*+>) < f (Д) - ly (2 - Ly) (f (?) ~ f (/)).

f (xk+ Ч-f (x*) < (1 - ly (2 - Ly)) (f (x*) - f (x*)) = q{ (f (xk) - f (x*)),

f (?) ~ f (?) < q\ (f (?) - f (?)), 91 = 1 - 2Zy 4- LZy2.

Поскольку 0 < у < 2/L, то 0 < qx < 1, и следовательно, f(xk)-+

-+f(x*). Из неравенства (35) § 1 следует

||x^~?||2<(2/Z)^(f(?)-f(?)). A

Рассмотрим еще более узкий класс функций — сильно вы-

пуклых дважды дифференцируемых.

Теорема 3. Пусть f(x) дважды дифференцируема и

H^f(x)^LI, Z > О, (13)

для всех х. Тогда при 0 < у < 2/L

||х'-х*1К||х°~- ?||?, <? = max {11 — yZ |, | 1 — уТ |) < 1. (14)

Величина q минимальна и равна

<7* = (LZ)/(L 4-Z) при y = y* = 2/(L4-Z). (15)

Доказательство. По формуле (13) § 1

1

Vf (?) = Vf (х*) 4- J V2/ (х* 4- т (xk - х*)) (xk - х’) dx = Ah (xk - x‘),

oJ

§ 4, ГРАДИЕНТНЫЙ МЕТОД

33

где в силу (13) lI<Ak^LI. Поэтому

II ^+> - х* || = II xk - X* - Wf Ю II =

= II (Z -yAk) (xft - x*) ||< || I - yAk || || xk - x* II.

Для всякой симметричной матрицы А имеем || / — Л || =

= шах {11 — Ат I, I 1 — I }> гДе и — наименьшее и наи-

большее собственные значения А. Поэтому ||xfe+1 —х*||<

< q || х-1 — х* ||, q = max {11 — yZ |, | 1 — yL |}. Поскольку 0 < у <

< 2/L, 0 < Z <L, то | 1 — у/1 < 1, | 1 — yL | < 1, т. е. q < 1. Ми-

нимизируя q по у, получаем (15). ▲

Покажем, что оценка скорости сходимости, даваемая теоре-

мой 3, точная, она достигается для любой квадратичной функ-

ции. Пусть f (х) = (Ах, х)/2 — (Ь, х), А > О, О <Z I — М дД %2 • •

.jT = L, где Хг — собственные числа матрицы А. Возьмем

произвольное 0 < у < 2/L. Предположим, что |1—у/|>|1 —

— yL|. Выберем х° = х* е1, где е1 — собственный вектор, от-

вечающий Xi, 11641 = 1. Тогда х* —-х* — (Z —уЛ)*(х° —х*) =

= (1 — уМ)М, IK— х*|| = | (1 — yZ) Р = 7&||х° — х*||. Анало-

гичным образом, если |1—yL | Дд 11—yZ|, то выберем х° —

== х* еп, еп — собственный вектор, отвечающий Ln, ||ел||= 1,

и получим также |lxft — х*|| = | (1 — yL) |k = gj|x° — х*||. Таким

образом, для всякого 0 < у < 2/L найдется х° такое, что ||х* —

— х*|| — <?41х° — х*||, <7 = max{| 1 —yZ|, | 1 —yL|}.

Оценку ||х*— х*|| дД(о*)ЯЛ— х*||, q*—(L—Z)/(L Z) нель-

зя улучшить, даже если выбирать у оптимальным образом для

каждого х°. Действительно, возьмем х° = х* -|- е1 еп (обозна-

чения те же, что и выше). Тогда при любом 0 < у < 2/L

хк - х' = (1- уД)к (хо _ (j _ Y/)fe ei _|_ (! _ yL)k

|| х* - х* || =4(1 - ylf 4- (1 - yL)2T1| х° - х* ||/V2.

Поэтому, если либо |1—yl\^> q*, либо |1—yL|> q*, то

IK— х*|| убывает медленнее, чем (q*)k. Но q — max {11—yZ|,

|1—yL|} еД q* лишь при у = у*, при этом |1—у*1\ --~

= |1 — y*L\ — q* и ||х*— х*|| = (^*)*||х° — х*||. Аналогичное рас-

суждение справедливо для любой точки х° такой, что

(х° —х*, е’)^0, (х° —х% en)^Q.

ф Локальный аналог теоремы 3 справедлив и для невыпуклых

Теорема 4. Пусть х* — невырожденная точка локального

минимума f(x). Тогда при 0 < у < 2/||V2f (х*) || метод (5) ло-

кально сходится к х* со скоростью геометрической прогрессии,

т.е. ля всякого 6 > 0 найдется е > 0 такое, что при ||х°—х*|К

Дае будет

II**-ЛК1|х°-х*||(<7 4-6)\

?==тах{|1 — у/|, | 1 — Y£|j < о < ZZ <V2f Ю <TZ.

36

ГЛ. I. ТЕОРИЯ И МЕТОДЫ БЕЗУСЛОВНОЙ МИНИМИЗАЦИИ

Величина q минимальна и равна q* = (L — /)/(£ + /) при у*

-2/(1 + /). А

Другие теоремы о сходимости градиентных методов при не-

сколько иных предположениях будут приведены в следующих

главах.

Упражнения.

1. Подробно разберите поведение градиентного метода (5) для следующих

функций на R1: а) |х|'+ а, 0 < а < 1; б) |х|2+ч, а > 0; в) х2; г) (1 + х2)~’.

При каких х° и у метод сходится, при каких расходится? Ответы, а) Схо-

димости нет при любом у > 0 и х° 0, при этом | хк | -> [*/2 (1 + а) у]1 ~а',

а знаки х'1 и х,<41 чередуются при k k0. б) Метод сходится, если

у(2 + а)|х°|“ <2, н расходится в противоположном случае, причем

|х*| s jxOj при у(2 а) |х°|“ = 2 и |х4|-^оо при у(2 + а) |х°| а > 2.

в) МетоД Сходится при 0 < у < 2 и расходится при у 2 и любом х° =^= 0,

при этом |х4| ав |х°|, если у = 2 и |х4|->оо при у > 2. г) |х*|->оо при

любом х° + 0.

00

2. Используя неравенство IIV/ (х*) ||2 < <х>, полученное при доказа-

ло

тельстве теоремы 1, покажите, что в ее условиях (х4)||2 — 0.

&->оо

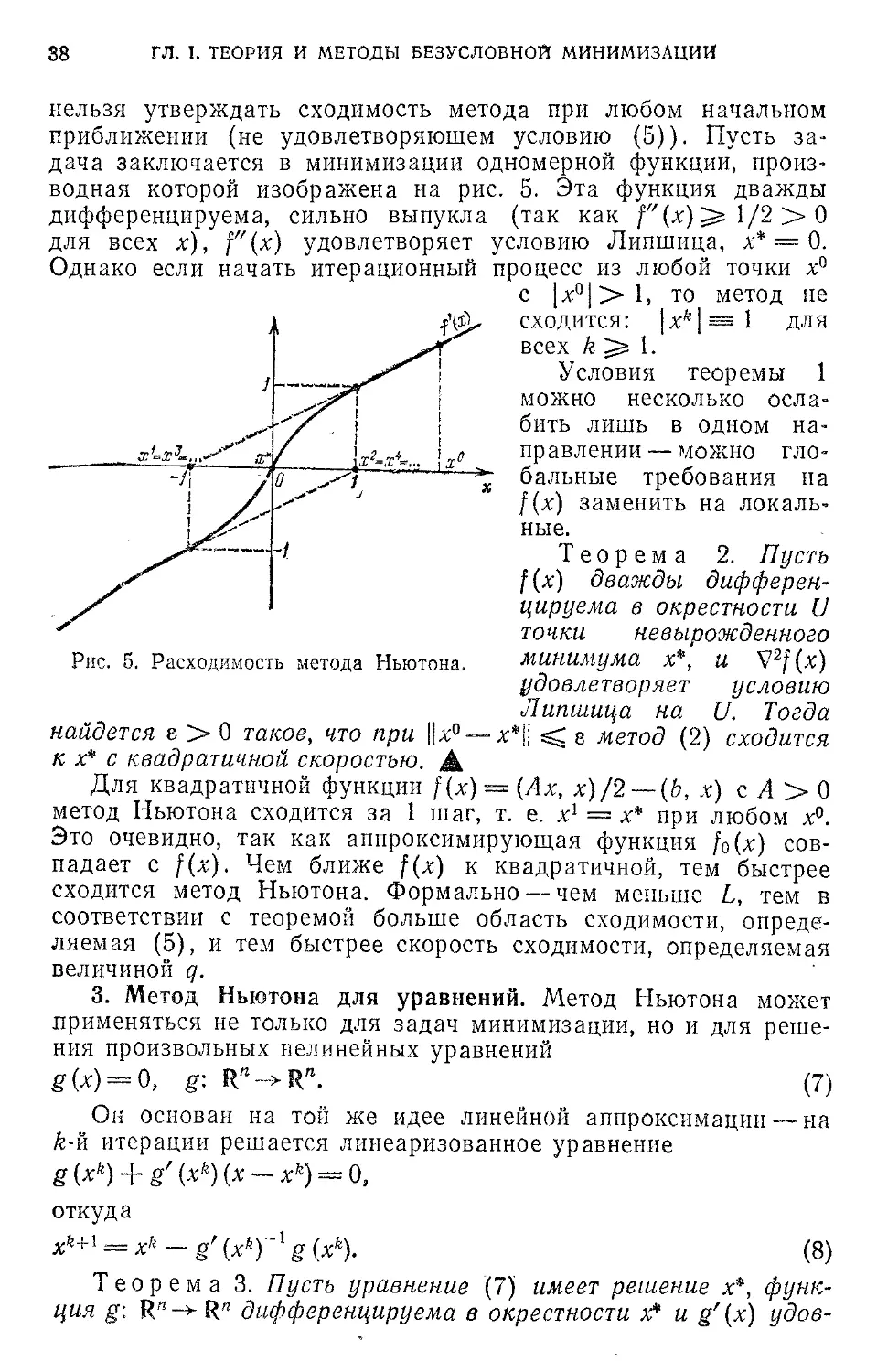

§ 5. Метод Ньютона

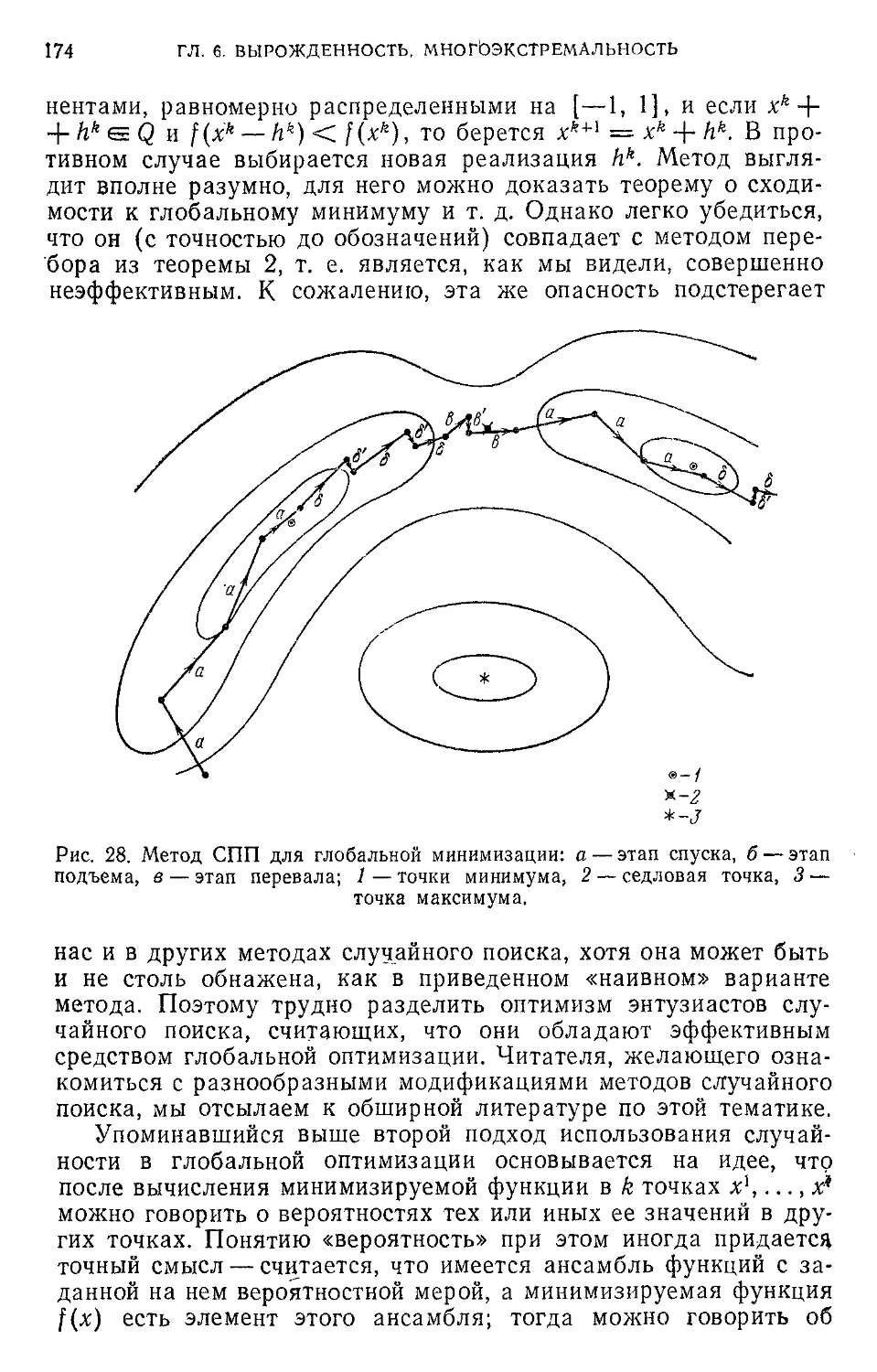

1. Эвристические соображения. В градиентном методе осно-