Автор: Клейнберг Дж. Тардос Е.

Теги: аппаратные средства техническое обеспечение программирование математика алгоритмы переводная литература издательство питер серия классика computer science алгоритмический анализ

ISBN: 978-5-496-01545-5

Год: 2016

Дж. Клейнберг, Е. Тардос

Алгоритмы: разработка и применение.

Классика Computers Science

Серия «Классика computer science»

Перевел с английского Е. Матвеев

Заведующая редакцией

Ведущий редактор

Художник

Корректоры

Верстка

Ю. Сергиенко

Н. Римицан

С. Маликова

Н. Викторова, И. Мивриньш

А. Шляго

ББК 32.973.2-018

УДК 004.3

Клейнберг Дж., Тардос Е.

К48

Алгоритмы: разработка и применение. Классика Computers Science / Пер. с англ.

Е. Матвеева. — СПб.: Питер, 2016. — 800 с.: ил. — (Серия «Классика computer

science»).

ISBN 978-5-496-01545-5

Впервые на русском языке выходит одна из самых авторитетных книг по разработке и использованию

алгоритмов. Алгоритмы — это основа программирования, определяющая, каким образом программное обеспечение будет использовать структуры данных.

Вы познакомитесь с базовыми аспектами построения алгоритмов, основными понятиями и определениями, структурами данных, затем перейдете к основным методам построения алгоритмов, неразрешимости

и методам решения неразрешимых задач, и, наконец, изучите рандомизацию при проектировании алгоритмов.

Самые сложные темы объясняются на четких и простых примерах, поэтому книга может использоваться

как для самостоятельного изучения студентами, так и учеными-исследователями или профессионалами

в области компьютерных технологий, которые хотят получить представление о применении тех или иных

методов проектирования алгоритмов.

Алгоритмический анализ состоит из двух фундаментальных компонентов: выделения математически

чистого ядра задачи и выявления методов проектирования подходящего алгоритма на основании структуры

задачи. И чем лучше аналитик владеет полным арсеналом возможных методов проектирования, тем быстрее

он начинает распознавать «чистые» формулировки, лежащие в основе запутанных задач реального мира.

12+ (В соответствии с Федеральным законом от 29 декабря 2010 г. № 436-ФЗ.)

ISBN 978-0132131087 англ.

ISBN 978-5-496-01545-5

Copyright © 2006 by Pearson Education, Inc.

© ООО Издательство «Питер», 2016

© Серия «Классика computer science», 2016

Права на издание получены по соглашению с Addison-Wesley Longman. Все права защищены. Никакая часть

данной книги не может быть воспроизведена в какой бы то ни было форме без письменного разрешения владельцев авторских прав.

Информация, содержащаяся в данной книге, получена из источников, рассматриваемых издательством как надежные. Тем не менее, имея в виду возможные человеческие или технические ошибки, издательство не может

гарантировать абсолютную точность и полноту приводимых сведений и не несет ответственности за возможные

ошибки, связанные с использованием книги.

ООО «Питер Пресс», 192102, Санкт-Петербург, ул. Андреевская (д. Волкова), 3, литер А, пом. 7Н.

Налоговая льгота — общероссийский классификатор продукции ОК 034-2014, 58.11.12.066 —

Книги печатные профессиональные, технические и научные.

Подписано в печать 28.01.16. Формат 70×100/16. Бумага писчая. Усл. п. л. 64,500. Тираж 1000. Заказ 0000.

Отпечатано в ОАО «Первая Образцовая типография». Филиал «Чеховский Печатный Двор».

142300, Московская область, г. Чехов, ул. Полиграфистов, 1.

Сайт: www.chpk.ru. E-mail: marketing@chpk.ru

Факс: 8(496) 726-54-10, телефон: (495) 988-63-87

Краткое содержание

Глава 1. Введение: некоторые типичные задачи . . . . . . . . . . . . . . . . . . . . . . 27

Глава 2. Основы анализа алгоритмов. . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 56

Глава 3. Графы . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 98

Глава 4. Жадные алгоритмы. . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 137

Глава 5. Разделяй и властвуй. . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 226

Глава 6. Динамическое программирование . . . . . . . . . . . . . . . . . . . . . . . . . 266

Глава 7. Нахождение потока в сети. . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 347

Глава 8. NP-полнота и вычислительная неразрешимость . . . . . . . . . . . . . 458

Глава 9. PSPACE: класс задач за пределами NP . . . . . . . . . . . . . . . . . . . . . . 534

Глава 10. Расширение пределов разрешимости . . . . . . . . . . . . . . . . . . . . . 555

Глава 11. Аппроксимирующие алгоритмы. . . . . . . . . . . . . . . . . . . . . . . . . . . 599

Глава 12. Локальный поиск . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 659

Глава 13. Рандомизированные алгоритмы . . . . . . . . . . . . . . . . . . . . . . . . . . 704

Оглавление

Предисловие . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 17

Общие сведения . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

Учебные аспекты и дополнения . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

Краткое содержание . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

Как пользоваться книгой . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

Благодарности . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

18

19

20

22

24

Глава 1. Введение: некоторые типичные задачи . . . . . . . . . . . . . . . . . . . . . . . 27

1.1. Первая задача: устойчивые паросочетания . . . . . . . . . . . . . . . . . . . . . . . . . . .

Задача . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

Проектирование алгоритма . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

Расширения . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

1.2. Пять типичных задач . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

Интервальное планирование . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

Взвешенное интервальное планирование . . . . . . . . . . . . . . . . . . . . . . . . .

Двудольные паросочетания . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

Независимое множество . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

Задача конкурентного размещения . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

Упражнения с решениями . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

Упражнение с решением 1 . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

Упражнение с решением 2 . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

Упражнения . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

Примечания и дополнительная литература . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

27

27

32

35

39

40

41

41

43

45

46

46

47

50

55

Глава 2. Основы анализа алгоритмов . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 56

2.1. Вычислительная разрешимость . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

Первые попытки определения эффективности . . . . . . . . . . . . . . . . . . . . .

Худшее время выполнения и поиск методом «грубой силы» . . . . . . . . .

Полиномиальное время как показатель эффективности . . . . . . . . . . . . .

2.2. Асимптотический порядок роста . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

O, Ω и Θ . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

Свойства асимптотических скоростей роста . . . . . . . . . . . . . . . . . . . . . . .

Асимптотические границы для некоторых

распространенных функций . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

2.3. Реализация алгоритма устойчивых паросочетаний

со списками и массивами . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

Массивы и списки . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

Реализация алгоритма устойчивых паросочетаний . . . . . . . . . . . . . . . . .

56

57

58

60

62

63

66

67

70

71

73

Оглавление

2.4. Обзор типичных вариантов времени выполнения . . . . . . . . . . . . . . . . . . . . . .

Линейное время . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

Время O(n log n) . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

Квадратичное время . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

Кубическое время . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

Время O(nk) . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

За границами полиномиального времени . . . . . . . . . . . . . . . . . . . . . . . . .

Сублинейное время . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

2.5. Более сложная структура данных: приоритетная очередь . . . . . . . . . . . . . . .

Задача . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

Структура данных для реализации приоритетной очереди . . . . . . . . . . .

Реализация операций с кучей . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

Реализация приоритетной очереди на базе кучи . . . . . . . . . . . . . . . . . . .

Упражнения с решениями . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

Упражнение с решением 1 . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

Упражнение с решением 2 . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

Упражнения . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

Примечания и дополнительная литература . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

7

74

75

77

78

79

80

81

82

83

84

85

87

90

91

91

92

93

96

Глава 3. Графы . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 98

3.1. Основные определения и применения . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 98

3.2. Связность графа и обход графа . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 103

Поиск в ширину . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 104

Связная компонента . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 106

Поиск в глубину . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 107

Набор всех компонент связности . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 110

3.3. Реализация перебора графа с использованием очередей и стеков . . . . . 111

Представление графов . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 111

Очереди и стеки . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 113

Реализация поиска в ширину . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 114

Реализация поиска в глубину . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 116

Определение всех компонент связности . . . . . . . . . . . . . . . . . . . . . . . . . 117

3.4. Проверка двудольности: практическое применение поиска в ширину . . . 118

Задача . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 118

Проектирование алгоритма . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 119

Анализ алгоритма . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 119

3.5. Связность в направленных графах . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 121

Представление направленных графов . . . . . . . . . . . . . . . . . . . . . . . . . . . 121

Алгоритмы поиска . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 121

Сильная связность . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 122

3.6. Направленные ациклические графы и топологическое упорядочение . . . 123

Задача . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 124

Проектирование и анализ алгоритма . . . . . . . . . . . . . . . . . . . . . . . . . . . . 126

Упражнения с решениями . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 128

Упражнение с решением 1 . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 128

Упражнение с решением 2 . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 129

Упражнения . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 131

Примечания и дополнительная литература . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 136

8

Оглавление

Глава 4. Жадные алгоритмы . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 137

4.1. Интервальное планирование: жадный алгоритм опережает . . . . . . . . . . . .

Проектирование жадного алгоритма . . . . . . . . . . . . . . . . . . . . . . . . . . . .

Анализ алгоритма . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

Расширения . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

Взаимосвязанная задача: планирование всех интервалов . . . . . . . . . .

4.2. Планирование для минимизации задержки: метод замены . . . . . . . . . . . .

Задача . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

Проектирование алгоритма . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

Анализ алгоритма . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

Расширения . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

4.3. Оптимальное кэширование: более сложный пример замены . . . . . . . . . . .

Задача . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

Разработка и анализ алгоритма . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

Расширения: кэширование в реальных рабочих условиях . . . . . . . . . .

4.4. Кратчайшие пути в графе . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

Задача . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

Разработка алгоритма . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

Анализ алгоритма . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

4.5. Задача нахождения минимального остовного дерева . . . . . . . . . . . . . . . . .

Задача . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

Разработка алгоритма . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

Анализ алгоритмов . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

Реализация алгоритма Прима . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

Расширения . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

4.6. Реализация алгоритма Крускала: структура Union-Find . . . . . . . . . . . . . . . .

Задача . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

Простая структура данных для структуры Union-Find . . . . . . . . . . . . . . .

Усовершенствованная структура данных Union-Find . . . . . . . . . . . . . . .

Дальнейшие улучшения . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

Реализация алгоритма Крускала . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

4.7. Кластеризация . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

Задача . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

Разработка алгоритма . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

Анализ алгоритма . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

4.8. Коды Хаффмана и сжатие данных . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

Задача . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

Разработка алгоритма . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

Анализ алгоритма . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

Расширения . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

4.9.* Ориентированные деревья с минимальной стоимостью:

многофазный жадный алгоритм . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

Задача . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

Разработка алгоритма . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

Анализ алгоритма . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

Упражнения с решениями . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

Упражнение с решением 1 . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

Упражнение с решением 2 . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

Упражнение с решением 3 . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

138

138

141

143

143

147

147

148

149

152

153

153

154

157

158

158

159

160

163

163

164

165

170

171

172

172

173

175

176

178

179

179

180

181

182

183

187

194

196

197

198

199

202

203

203

206

207

Оглавление

9

Упражнения . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 209

Примечания и дополнительная литература . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 224

Глава 5. Разделяй и властвуй . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 226

5.1. Первое рекуррентное отношение: алгоритм сортировки слиянием . . . . .

Методы разрешения рекуррентности . . . . . . . . . . . . . . . . . . . . . . . . . . . .

Раскрутка рекуррентности в алгоритме сортировки слиянием . . . . . .

Подстановка решения в рекуррентное отношение сортировки

слиянием . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

Использование частичной подстановки . . . . . . . . . . . . . . . . . . . . . . . . . .

5.2. Другие рекуррентные отношения . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

Случай q > 2 подзадач . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

Случай одной подзадачи . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

Похожее рекуррентное отношение: T(n) ≤ 2T(n/2) + O(n2) . . . . . . . . . . .

5.3. Подсчет инверсий . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

Задача . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

Разработка и анализ алгоритма . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

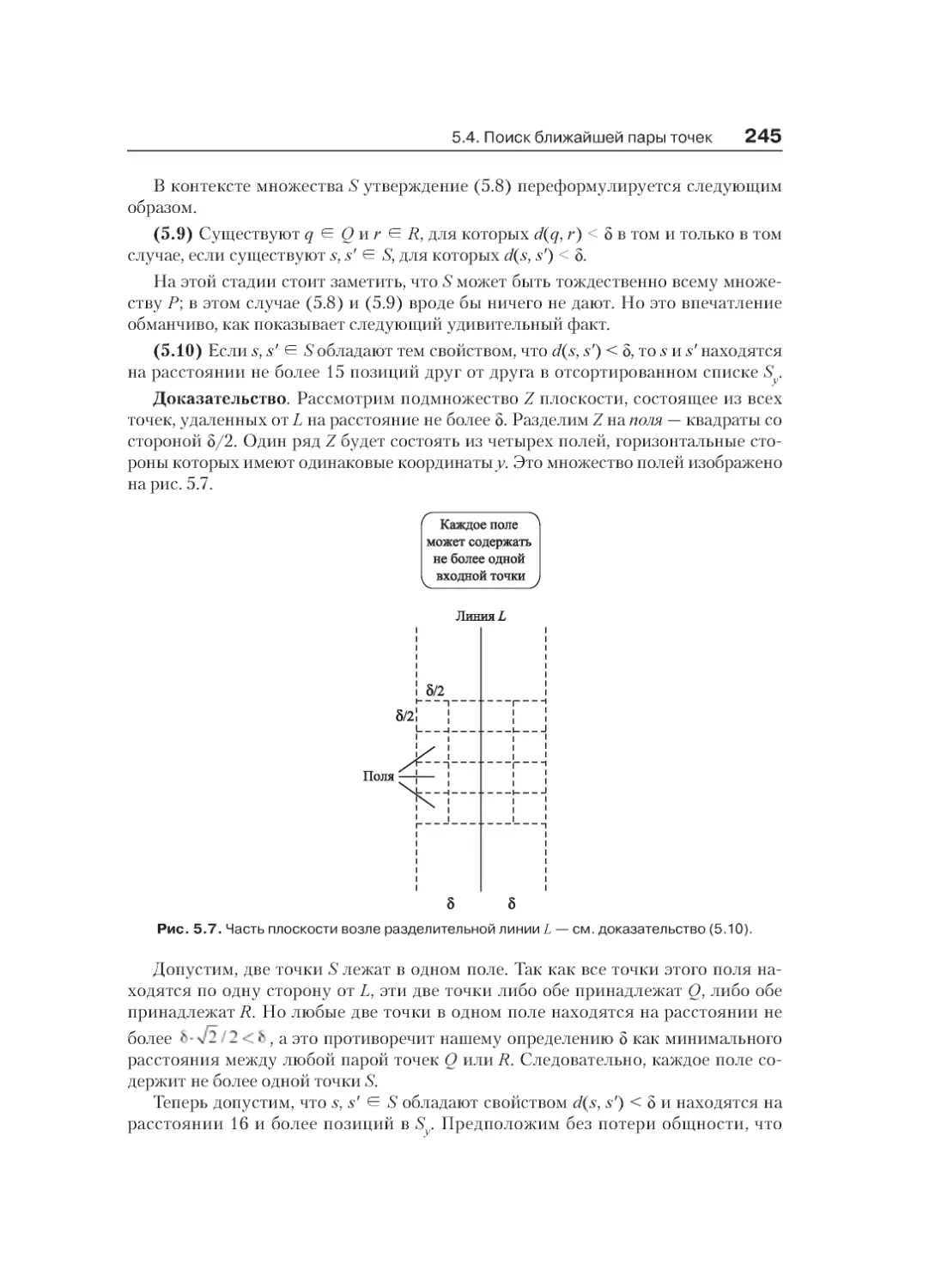

5.4. Поиск ближайшей пары точек . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

Задача . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

Разработка алгоритма . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

Анализ алгоритма . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

5.5. Целочисленное умножение . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

Задача . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

Разработка алгоритма . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

Анализ алгоритма . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

5.6. Свертки и быстрое преобразование Фурье . . . . . . . . . . . . . . . . . . . . . . . . . .

Задача . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

Разработка и анализа алгоритма . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

Упражнения с решениями . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

Упражнение с решением 1 . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

Упражнение с решением 2 . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

Упражнения . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

Примечания и дополнительная литература . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

227

228

229

230

230

231

232

234

236

238

238

239

242

242

242

247

248

248

248

250

250

250

254

258

258

260

262

265

Глава 6. Динамическое программирование . . . . . . . . . . . . . . . . . . . . . . . . . 266

6.1. Взвешенное интервальное планирование: рекурсивная процедура . . . . .

Разработка рекурсивного алгоритма . . . . . . . . . . . . . . . . . . . . . . . . . . . .

Мемоизация рекурсии . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

Анализ мемоизированной версии . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

Вычисление решения помимо его значения . . . . . . . . . . . . . . . . . . . . . .

6.2. Принципы динамического программирования: мемоизация

или итерации с подзадачами . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

Разработка алгоритма . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

Анализ алгоритма . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

Основная схема динамического программирования . . . . . . . . . . . . . . .

6.3. Сегментированные наименьшие квадраты: многовариантный выбор . . .

Задача . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

Разработка алгоритма . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

267

267

271

271

272

272

273

273

274

275

276

278

10

Оглавление

Анализ алгоритма . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

6.4. Задача о сумме подмножеств и задача о рюкзаке:

добавление переменной . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

Задача . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

Разработка алгоритма . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

Анализ алгоритма . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

6.5. Вторичная структура РНК: динамическое программирование

по интервалам . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

Задача . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

Разработка и анализ алгоритма . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

6.6. Выравнивание последовательностей . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

Задача . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

Разработка алгоритма . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

Анализ алгоритма . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

6.7. Выравнивание последовательностей в линейном пространстве

по принципу «разделяй и властвуй» . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

Задача . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

Разработка алгоритма . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

Анализ алгоритма . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

6.8. Кратчайшие пути в графе . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

Задача . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

Разработка и анализ алгоритма . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

Расширения: основные усовершенствования алгоритма . . . . . . . . . . .

6.9. Кратчайшие пути и дистанционно-векторные протоколы . . . . . . . . . . . . . .

Недостатки дистанционно-векторного протокола . . . . . . . . . . . . . . . . .

6.10. Отрицательные циклы в графе . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

Задача . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

Разработка и анализ алгоритма . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

Расширения: улучшенные алгоритмы нахождения кратчайшего

пути и отрицательного цикла . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

Упражнения с решениями . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

Упражнение с решением 1 . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

Упражнение с решением 2 . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

Упражнения . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

Примечания и дополнительная литература . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

280

281

281

282

284

286

287

289

291

291

294

296

297

298

298

302

303

303

305

308

311

313

315

315

316

317

320

320

322

325

345

Глава 7. Нахождение потока в сети . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 347

7.1. Задача о максимальном потоке и алгоритм Форда–Фалкерсона . . . . . . .

Разработка алгоритма . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

Анализ алгоритма: завершение и время выполнения . . . . . . . . . . . . . .

7.2. Максимальные потоки и минимальные разрезы . . . . . . . . . . . . . . . . . . . . . .

Анализ алгоритма: потоки и разрезы . . . . . . . . . . . . . . . . . . . . . . . . . . . .

Анализ алгоритма: максимальный поток равен

минимальному разрезу . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

Дальнейший анализ: целочисленные потоки . . . . . . . . . . . . . . . . . . . . . .

7.3. Выбор хороших увеличивающих путей . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

Разработка ускоренного алгоритма потока . . . . . . . . . . . . . . . . . . . . . . .

Анализ алгоритма . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

Расширения: сильные полиномиальные алгоритмы . . . . . . . . . . . . . . .

348

351

355

356

356

358

360

362

362

364

366

Оглавление

7.4.* Алгоритм проталкивания предпотока . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

Разработка алгоритма . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

Анализ алгоритма . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

Расширения: улучшенная версия алгоритма . . . . . . . . . . . . . . . . . . . . . .

Реализация алгоритма проталкивания предпотока . . . . . . . . . . . . . . . .

7.5. Первое применение: задача о двудольном паросочетании . . . . . . . . . . . . .

Задача . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

Разработка алгоритма . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

Анализ алгоритма . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

Расширения: структура двудольных графов

без идеального паросочетания . . . . . . . . . . . . . . . . . . . . . . . . . . . .

7.6. Непересекающиеся пути в направленных и ненаправленных графах . . . .

Задача . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

Разработка алгоритма . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

Анализ алгоритма . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

Расширения: непересекающиеся пути в ненаправленных графах . . .

7.7. Расширения задачи о максимальном потоке . . . . . . . . . . . . . . . . . . . . . . . . .

Задача: циркуляция с потреблением . . . . . . . . . . . . . . . . . . . . . . . . . . . .

Разработка и анализ алгоритма для циркуляций . . . . . . . . . . . . . . . . . .

Задача: циркуляция с потреблением и нижние границы . . . . . . . . . . . .

Разработка и анализ алгоритма с нижними границами . . . . . . . . . . . . .

7.8. Планирование опроса . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

Задача . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

Разработка алгоритма . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

Анализ алгоритма . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

7.9. Планирование авиаперелетов . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

Задача . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

Разработка алгоритма . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

Анализ алгоритма . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

Расширения: моделирование других аспектов задачи . . . . . . . . . . . . .

7.10. Сегментация изображений . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

Задача . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

Разработка и анализ алгоритма . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

7.11. Выбор проекта . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

Задача . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

Разработка алгоритма . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

Анализ алгоритма . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

7.12. Выбывание в бейсболе . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

Задача . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

Разработка и анализ алгоритма . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

Характеристика выбывания команды . . . . . . . . . . . . . . . . . . . . . . . . . . . .

7.13.* Добавление стоимостей в задачу паросочетаний . . . . . . . . . . . . . . . . . . .

Задача . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

Разработка и анализ алгоритма . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

Расширения: экономическая интерпретация цен . . . . . . . . . . . . . . . . . .

Упражнения с решениями . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

Упражнение с решением 1 . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

Упражнение с решением 2 . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

Упражнения . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

Примечания и дополнительная литература . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

11

367

367

370

374

375

377

377

377

378

380

383

383

383

384

387

388

388

390

392

392

394

395

396

396

397

397

399

400

400

401

401

403

405

406

406

407

409

410

411

413

414

414

415

419

420

420

421

424

456

12

Оглавление

Глава 8. NP-полнота и вычислительная неразрешимость . . . . . . . . . . . . . . 458

8.1. Полиномиальное сведение . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

Первое сведение: независимое множество и вершинное покрытие . .

Сведение к более общему случаю: вершинное покрытие

к покрытию множества . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

8.2. Сведение с применением «регуляторов»: задача выполнимости . . . . . . . .

Задачи SAT и 3-SAT . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

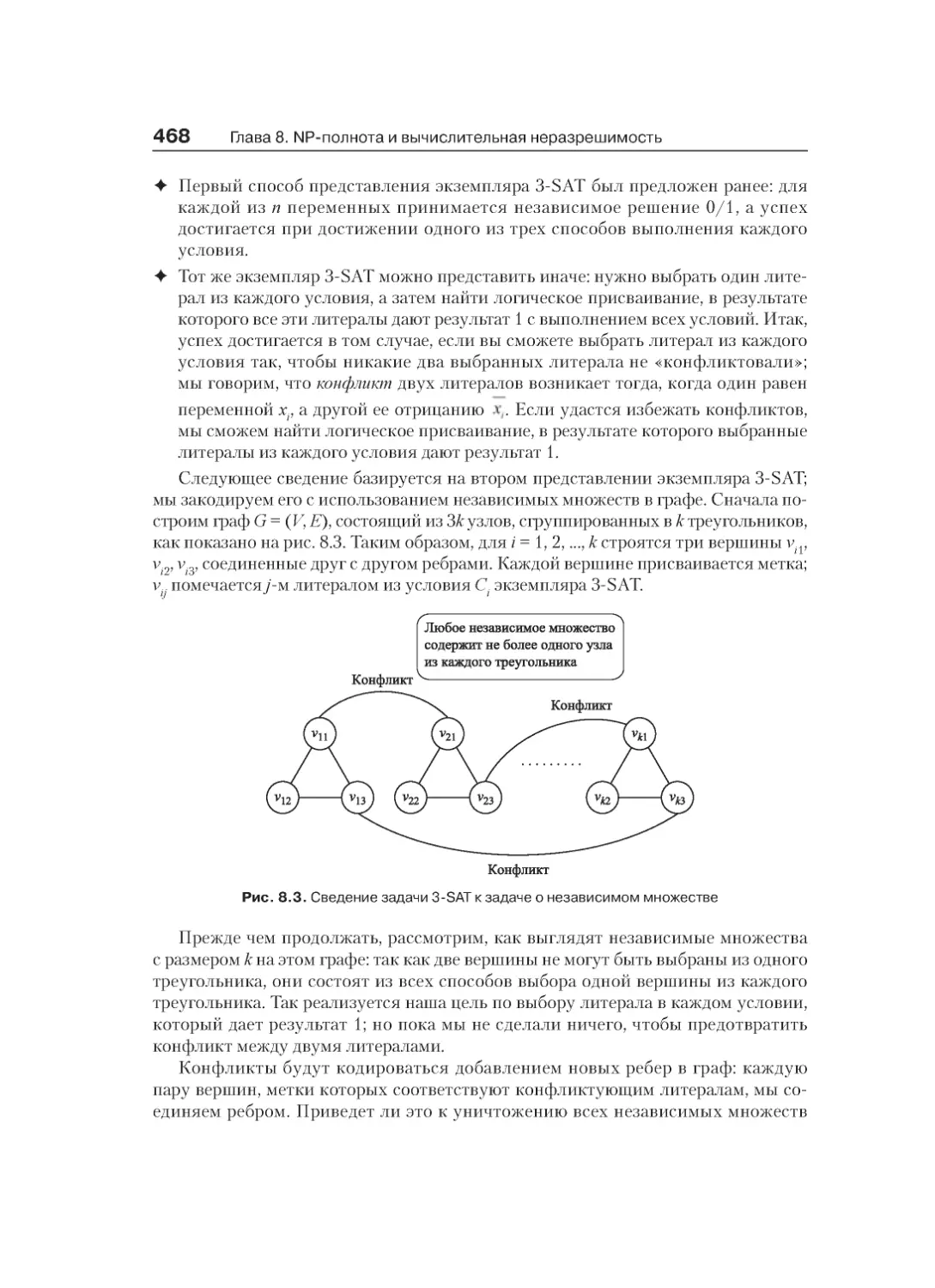

Сведение задачи 3-SAT к задаче о независимом множестве . . . . . . . .

Транзитивность сведения . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

8.3. Эффективная сертификация и определение NP . . . . . . . . . . . . . . . . . . . . . .

Задачи и алгоритмы . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

Эффективная сертификация . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

NP: класс задач . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

8.4. NP-полные задачи . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

Выполнимость булевой схемы: первая NP-полная задача . . . . . . . . . .

Пример . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

Доказательство NP-полноты других задач . . . . . . . . . . . . . . . . . . . . . . . .

Общая стратегия доказательства NP-полноты новых задач . . . . . . . . .

8.5. Задачи упорядочения . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

Задача коммивояжера . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

Задача о гамильтоновом цикле . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

Доказательство NP-полноты задачи о гамильтоновом цикле . . . . . . . .

Доказательство NP-полноты задачи коммивояжера . . . . . . . . . . . . . . .

Расширения: задача о гамильтоновом пути . . . . . . . . . . . . . . . . . . . . . . .

8.6. Задачи о разбиении . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

Задача о трехмерном сочетании . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

Доказательство NP-полноты трехмерного сочетания . . . . . . . . . . . . . .

8.7. Задача о раскраске графа . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

Задача о раскраске графа . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

Вычислительная сложность задачи о раскраске графа . . . . . . . . . . . . .

Доказательство NP-полноты задачи о 3-раскраске . . . . . . . . . . . . . . . .

Заключение: о проверке гипотезы четырех цветов . . . . . . . . . . . . . . . .

8.8. Численные задачи . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

Задача о суммировании подмножеств . . . . . . . . . . . . . . . . . . . . . . . . . . .

Доказательство NP-полноты задачи о суммировании подмножеств . .

Расширения: сложность некоторых задач планирования . . . . . . . . . . .

Внимание: суммирование подмножеств с полиномиально

ограничиваемыми числами . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

8.9. Co-NP и асимметрия NP . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

Хорошая характеризация: класс NPҏco-NP . . . . . . . . . . . . . . . . . . . . . .

8.10. Частичная классификация сложных задач . . . . . . . . . . . . . . . . . . . . . . . . . .

Задачи упаковки . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

Задачи покрытия . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

Задачи разбиения . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

Задачи упорядочения . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

Численные задачи . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

Задачи соблюдения ограничений . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

Упражнения с решениями . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

Упражнение с решением 1 . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

Упражнение с решением 2 . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

459

461

463

466

466

467

469

470

470

471

471

473

473

475

476

479

480

480

481

482

485

486

487

487

488

492

492

493

494

497

497

497

498

500

501

502

503

504

505

505

505

506

506

507

507

507

509

Оглавление

13

Упражнения . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 511

Примечания и дополнительная литература . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 532

Глава 9. PSPACE: класс задач за пределамиNP . . . . . . . . . . . . . . . . . . . . . 534

9.1. PSPACE . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

9.2. Некоторые сложные задачи из PSPACE . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

Задачи построения плана . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

Кванторы . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

Игры . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

9.3. Решение задач с кванторами и игровых задач в полиномиальном

пространстве . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

Разработка алгоритма для QSAT . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

Анализ алгоритма . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

Расширения: алгоритм для задачи конкурентного размещения . . . . .

9.4. Решение задачи построения плана с полиномиальным пространством . .

Задача . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

Разработка алгоритма . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

Анализ алгоритма . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

9.5. Доказательство PSPACE-полноты задач . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

Связь задач с кванторами с игровыми задачами . . . . . . . . . . . . . . . . . .

Доказательство PSPACE-полноты задачи конкурентного

размещения . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

Упражнения с решениями . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

Упражнение с решением 1 . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

Упражнения . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

Примечания и дополнительная литература . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

534

536

536

537

538

539

539

540

540

541

541

543

545

546

546

547

549

549

552

553

Глава 10. Расширение пределов разрешимости . . . . . . . . . . . . . . . . . . . . . 555

10.1. Поиск малых вершинных покрытий . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

Задача . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

Разработка алгоритма . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

Анализ алгоритма . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

10.2. Решение NP-сложных задач для деревьев . . . . . . . . . . . . . . . . . . . . . . . . . .

Жадный алгоритм для задачи о независимом множестве

для деревьев . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

Независимое множество с максимальным весом для деревьев . . . . .

10.3. Раскраска множества дуг . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

Задача . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

Разработка алгоритма . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

Анализ алгоритма . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

10.4.* Декомпозиция графа в дерево . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

Определение древовидной ширины . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

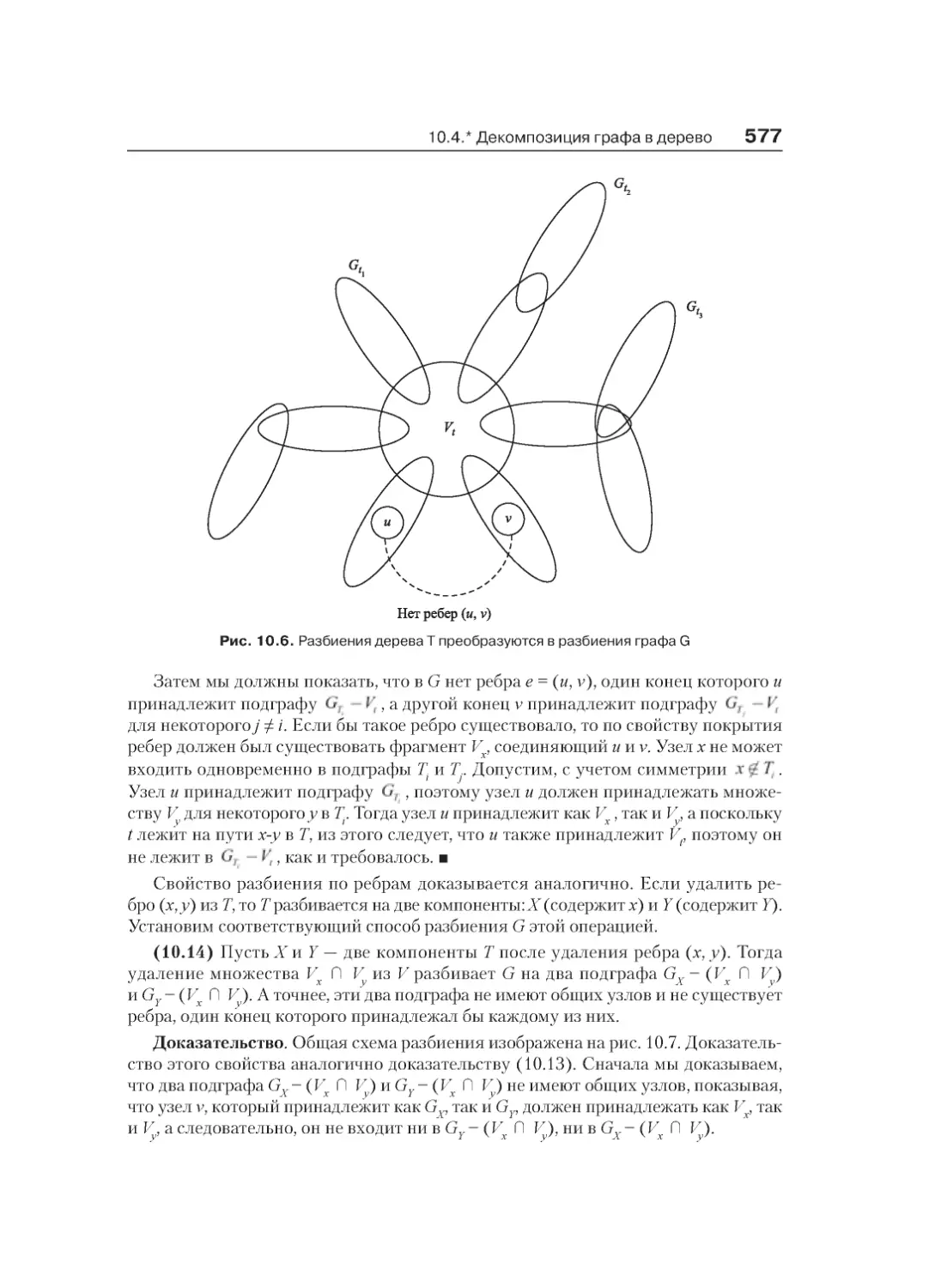

Свойства декомпозиции . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

Динамическое программирование и древовидная декомпозиция . . .

10.5.* Построение древовидной декомпозиции . . . . . . . . . . . . . . . . . . . . . . . . . .

Задача . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

Разработка и анализ алгоритма . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

Упражнения с решениями . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

Упражнение с решением 1 . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

556

557

557

559

559

560

562

564

564

567

572

573

574

576

580

584

585

585

591

591

14

Оглавление

Упражнения . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 594

Примечания и дополнительная литература . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 598

Глава 11. Аппроксимирующие алгоритмы . . . . . . . . . . . . . . . . . . . . . . . . . . 599

11.1. Жадные алгоритмы и ограничения оптимума:

задача распределения нагрузки . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

Задача . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

Разработка алгоритма . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

Анализ алгоритма . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

Расширения: улучшенный аппроксимирующий алгоритм . . . . . . . . . . .

11.2. Задача о выборе центров . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

Задача . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

Разработка и анализ алгоритма . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

11.3. Покрытие множества: обобщенная жадная эвристика . . . . . . . . . . . . . . . .

Задача . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

Разработка алгоритма . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

Анализ алгоритма . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

11.4. Метод назначения цены: вершинное покрытие . . . . . . . . . . . . . . . . . . . . . .

Задача . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

Разработка алгоритма: метод назначения цены . . . . . . . . . . . . . . . . . . .

Анализ алгоритма . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

11.5. Максимизация методом назначения цены:

задача о непересекающихся путях . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

Задача . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

Разработка и анализ жадного алгоритма . . . . . . . . . . . . . . . . . . . . . . . . .

Разработка и анализ алгоритма назначения цены . . . . . . . . . . . . . . . . .

11.6. Линейное программирование и округление: применение к задаче

о вершинном покрытии . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

Линейное программирование как обобщенный метод . . . . . . . . . . . . .

Задача о вершинном покрытии как целочисленная программа . . . . . .

Использование линейного программирования для задачи

вершинного покрытия . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

11.7.* Снова о распределении нагрузки: более сложное применение LP . . . . .

Задача . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

Разработка и анализ алгоритма . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

11.8. Аппроксимации с произвольной точностью: задача о рюкзаке . . . . . . . .

Задача . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

Разработка алгоритма . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

Анализ алгоритма . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

Новый алгоритм динамического программирования для задачи

о рюкзаке . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

Упражнения с решениями . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

Упражнение с решением 1 . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

Решение . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

Упражнения . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

Примечания и дополнительная литература . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

600

600

600

601

604

605

605

606

611

611

612

612

616

617

618

621

622

622

624

626

629

629

632

634

635

636

637

642

643

644

645

646

648

648

648

649

657

Глава 12. Локальный поиск . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 659

12.1. Задача оптимизации в перспективе . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 660

Потенциальная энергия . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 660

Оглавление

Связь с оптимизацией . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

Локальный поиск в задаче о вершинном покрытии . . . . . . . . . . . . . . . .

12.2. Алгоритм Метрополиса и имитация отжига . . . . . . . . . . . . . . . . . . . . . . . . .

Алгоритм Метрополиса . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

Имитация отжига . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

12.3. Применение локального поиска в нейронных сетях Хопфилда . . . . . . . . .

Задача . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

Разработка алгоритма . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

Анализ алгоритма . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

12.4. Аппроксимация задачи о максимальном разрезе

с применением локального поиска . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

Задача . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

Разработка алгоритма . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

Анализ алгоритма . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

12.5. Выбор соседского отношения . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

Алгоритмы локального поиска при разбиении графов . . . . . . . . . . . . .

12.6.* Классификация на базе локального поиска . . . . . . . . . . . . . . . . . . . . . . . .

Задача . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

Разработка алгоритма . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

Анализ алгоритма . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

12.7. Динамика наилучших ответов и равновесия Нэша . . . . . . . . . . . . . . . . . . .

Задача . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

Динамика наилучших ответов и равновесия Нэша:

определения и примеры . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

Связь с локальным поиском . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

Два основных вопроса . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

Поиск хорошего равновесия Нэша . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

Упражнения с решениями . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

Упражнение с решением 1 . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

Упражнения . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

Примечания и дополнительная литература . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

15

662

663

665

665

667

669

669

670

671

674

674

675

675

677

678

679

680

681

686

688

688

689

691

693

694

698

698

700

703

Глава 13. Рандомизированные алгоритмы . . . . . . . . . . . . . . . . . . . . . . . . . . 704

13.1. Первое применение: разрешение конфликтов . . . . . . . . . . . . . . . . . . . . . .

Задача . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

Разработка рандомизированного алгоритма . . . . . . . . . . . . . . . . . . . . .

Анализ алгоритма . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

13.2. Нахождение глобального минимального разреза . . . . . . . . . . . . . . . . . . . .

Задача . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

Разработка алгоритма . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

Анализ алгоритма . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

Дальнейший анализ: количество глобальных

минимальных разрезов . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

13.3. Случайные переменные и ожидания . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

Пример: ожидание первого успеха . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

Линейность ожидания . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

Пример: угадывание карт . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

Пример: сбор купонов . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

Последнее определение: условное ожидание . . . . . . . . . . . . . . . . . . . .

705

706

706

706

711

711

712

713

715

716

717

717

718

719

721

16

Оглавление

13.4. Рандомизированный аппроксимирующий алгоритм

для задачи MAX 3-SAT . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

Задача . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

Разработка и анализ алгоритма . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

Дальнейший анализ: поиск хорошего присваивания . . . . . . . . . . . . . . .

13.5. Рандомизация принципа ««разделяй и властвуй»:

нахождение медианы и быстрая сортировка . . . . . . . . . . . . . . . . . . . . . . . . . .

Задача: нахождение медианы . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

Разработка алгоритма . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

Анализ алгоритма . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

Второй пример: быстрая сортировка . . . . . . . . . . . . . . . . . . . . . . . . . . . .

13.6. Хеширование: рандомизированная реализация словарей . . . . . . . . . . . .

Задача . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

Разработка структуры данных . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

Универсальные классы хеш-функций . . . . . . . . . . . . . . . . . . . . . . . . . . . .

Анализ структуры данных . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

13.7. Нахождение ближайшей пары точек: рандомизированный метод . . . . . .

Задача . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

Разработка алгоритма . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

Описание алгоритма . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

Анализ алгоритма . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

13.8. Рандомизация кэширования . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

Задача . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

Разработка класса алгоритмом маркировки . . . . . . . . . . . . . . . . . . . . . .

Анализ алгоритмов маркировки . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

Разработка рандомизированного алгоритма маркировки . . . . . . . . . .

Анализ рандомизированного алгоритма маркировки . . . . . . . . . . . . . .

13.9. Границы Чернова . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

13.10. Распределение нагрузки . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

Задача . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

Анализ случайного распределения заданий . . . . . . . . . . . . . . . . . . . . . .

13.11. Маршрутизация пакетов . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

Задача . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

Разработка алгоритма . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

Анализ алгоритма . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

13.12. Основные вероятностные определения . . . . . . . . . . . . . . . . . . . . . . . . . . .

Конечные вероятностные пространства . . . . . . . . . . . . . . . . . . . . . . . . . .

Условная вероятность и независимость . . . . . . . . . . . . . . . . . . . . . . . . . .

Бесконечные пространства выборки . . . . . . . . . . . . . . . . . . . . . . . . . . . .

Упражнения с решениями . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

Упражнение с решением 1 . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

Упражнение с решением 2 . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

Упражнения . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

Примечания и дополнительная литература . . . . . . . . . . . . . . . . . . . . . . . . . . . . . .

721

721

722

723

725

725

725

728

729

731

732

733

735

737

738

739

740

743

743

747

747

748

749

751

752

754

756

756

757

759

759

762

763

765

765

767

770

772

772

775

778

789

Эпилог: алгоритмы, которые работают бесконечно . . . . . . . . . . . . . . . . . . 791

Задача . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 792

Разработка алгоритма . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 795

Анализ алгоритма . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 799

Об авторах . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 800

Предисловие

Алгоритмические идеи вездесущи, а широта их применения наглядно проявляется

в примерах как из области информатики, так и за ее пределами. Некоторые серьезные изменения стандартов маршрутизации в Интернете произошли вследствие

обсуждения недостатков одного алгоритма кратчайшего пути и относительных

преимуществ другого. Базовые понятия, используемые биологами для выражения

сходства между генами и геномами, имеют алгоритмические определения. Озабоченность, высказываемая экономистами в контексте практической приемлемости

комбинаторных аукционов, отчасти обусловлена тем фактом, что особыми случаями таких аукционов являются вычислительно трудноразрешимые задачи поиска.

При этом алгоритмические концепции не ограничиваются хорошо известными,

устоявшимися задачами; эти идеи регулярно проявляются в совершенно новых

проблемах, возникающих в самых разных областях. Ученый из Yahoo!, однажды

рассказавший нам за обедом о системе поставки рекламы пользователям, описывал

совокупность задач, которые, по сути, можно было смоделировать как задачу нахождения потока в сети. То же произошло в общении с нашим бывшим студентом

(ныне консультантом по вопросам управления, занимающимся правилами подбора

персонала для крупных больниц), с которым мы встретились во время поездки

в Нью-Йорк.

Дело даже не в том, что алгоритмы находят разнообразные применения. Другое,

более глубокое соображение заключается в том, что тема алгоритмов превращается

в мощную линзу, через которую можно рассматривать область вычислительных

технологий вообще. Алгоритмические задачи образуют ядро компьютерной науки, однако они редко появляются в виде аккуратно упакованных, математически

точных вопросов. Чаще они отягощаются множеством хлопотных подробностей,

привязанных к конкретному случаю; одни из этих подробностей важны, другие избыточны. В результате алгоритмический анализ состоит из двух фундаментальных

компонентов: выделения математически чистого ядра задачи и выявления методов

проектирования подходящего алгоритма на основании структуры задачи. Эти два

компонента взаимосвязаны: чем лучше аналитик владеет полным арсеналом возможных методов проектирования, тем быстрее он начинает распознавать «чистые»

формулировки, лежащие в основе запутанных задач реального мира. Таким образом, при использовании с максимальной эффективностью алгоритмические идеи

не просто предоставляют решения четко поставленных задач — они формируют

язык для четкого выражения вопросов, заложенных в их основу.

Цель этой книги — донести до читателя этот подход к алгоритмам в форме

процесса проектирования, который начинается с задач, встречающихся по всему

18

Предисловие

диапазону вычислительных приложений, использует хорошее понимание методов

проектирования алгоритмов и конечным результатом которого является разработка

эффективных решений таких задач. Мы будем изучать роль алгоритмических идей

в компьютерной науке вообще и постараемся связать эти идеи с диапазоном точно

сформулированных задач, для решения которых проектируются и анализируются

алгоритмы. Иначе говоря, какие причины заставляют нас искать решение этих задач и как мы выбираем конкретные способы их формулировки? Как мы узнаем,

какие принципы проектирования уместны в той или иной ситуации?

Исходя из сказанного, мы постарались показать, как выявлять «чистые» формулировки алгоритмических задач в сложных вычислительных областях и как на

базе этих формулировок проектировать эффективные алгоритмы для решения

полученных задач. Чтобы разобраться в сложном алгоритме, часто бывает проще

всего реконструировать последовательность идей (включая неудачные заходы

и тупики), которые привели от исходных упрощенных методов к выработанному со

временем решению. Так сформировался стиль изложения, не приводящий читателя

от постановки задачи сразу к алгоритму и, на наш взгляд, лучше отражающий то,

как мы и наши коллеги подходим к решению подобных задач.

Общие сведения

Книга предназначена для студентов, прошедших двухсеместровый вводный курс

вычислительных технологий (стандартный курс «CS1/CS2»), в ходе которого

они писали программы для реализации базовых алгоритмов, и работы с такими

структурами данных, как деревья и графы, а также с базовыми структурами данных

(массивы, списки, очереди и стеки). Так как переход между этим курсом и первым

курсом по алгоритмам еще не стал стандартным, книга открывается с изложения

тем, которые знакомы студентам некоторых образовательных учреждений по курсу

CS1/CS2, но в других учреждениях включаются в учебный план первого курса по

алгоритмам. Соответственно, эта часть может рассматриваться либо как обзор, либо

как новый материал; включая ее, мы надеемся, что книга может быть использована

в более широком диапазоне учебных курсов и с большей гибкостью в отношении

исходных знаний, обязательных для читателя.

В соответствии с описанным подходом мы разрабатываем базовые методы проектирования алгоритмов, изучая задачи из многих областей компьютерной науки

и сопутствующих областей. В частности, приводятся довольно подробные описания возможных применений из области систем и сетей (кэширование, коммутация,

междоменная маршрутизация в Интернете), искусственного интеллекта (планирование, игры, сети Хопфилда), распознавание образов (сегментация изображений), извлечение информации (обнаружение точки перехода, кластеризация),

исследование операций (планирование воздушного движения) и вычислительная

биология (выравнивание последовательностей, вторичная структура РНК).

Понятие вычислительной неразрешимости и NP-полноты в частности играет

значительную роль в книге. Это соответствует нашему подходу к общему процессу

Учебные аспекты и дополнения

19

проектирования алгоритма. Иногда интересная задача, возникающая в практической области, имеет эффективное решение, а иногда она оказывается доказуемо

NP-полной; для полноценного подхода к решению новой алгоритмической задачи

вы должны уметь исследовать оба варианта с равной уверенностью. Поскольку

очень многие естественные задачи в компьютерной науке являются NP-полными,

разработка механизмов работы с неразрешимыми задачами стала ключевым фактором изучения алгоритмов, и эта тема широко представлена в книге. Вывод о том,

что задача является NP-полной, следует воспринимать не как конец исследования,

а как приглашение к поиску алгоритмов приближения, методов эвристического

локального поиска или разрешимых особых случаев. Каждый из этих трех подходов широко рассматривается в книге.

Чтобы упростить работу с такими задачами, в каждую главу включается раздел «Упражнения с решениями», в котором мы берем одну или несколько задач

и подробно описываем процесс поиска решения. По этой причине обсуждение

каждого упражнения с решением получается намного длиннее, чем простая запись

полного, правильного решения (другими словами, намного длиннее, чем было необходимо для полноценного решения, если бы эта задача была задана студенту для

самостоятельного решения). Как и в остальном тексте книги, обсуждения в этих

разделах должны дать читателю представление о более масштабных процессах,

применяемых для решения задач такого типа и в конечном итоге приводящих

к точному решению.

Стоит упомянуть еще два обстоятельства, связанных с использованием этих задач для самостоятельной работы в учебных курсах. Во-первых, задачи упорядочены

приблизительно по возрастанию сложности, но это всего лишь приблизительный

ориентир, и мы не советуем уделять ему слишком много внимания; так как основная

часть задач была разработана для самостоятельной работы студентов, большие подмножества задач в каждой главе довольно тесно связаны в отношении сложности.

Во-вторых, если не считать начальных глав, над решением этих задач придется

потрудиться — как для того, чтобы связать описание задачи с алгоритмическими

методами, описанными в главе, так и для непосредственного проектирования алгоритма. В своем учебном курсе мы назначали около трех таких задач на неделю.

Учебные аспекты и дополнения

Кроме задач и упражнений с решениями, в этой книге используется ряд других

учебных аспектов, а также дополнения, упрощающие ее применение в учебных

целях.

Как упоминалось ранее, многие разделы в книге посвящены формулировке

алгоритмической задачи (включая ее историю и мотивацию для поиска решения),

проектированию и анализу алгоритма для ее решения. В соответствии с этим стилем такие разделы имеют единую структуру, включающую последовательность

подразделов: «Задача» с описанием задачи и ее точной формулировкой; «Проектирование алгоритма» с применением подходящих методов для разработки

20

Предисловие

алгоритма; и «Анализ алгоритма» с доказательством свойств алгоритма и анализом

его эффективности. В тех случаях, где рассматриваются расширения задачи или

приводится дополнительный анализ алгоритма, включаются дополнительные подразделы. Целью такой структуры является введение относительно общего стиля

изложения, который переходит от исходного обсуждения проблемы, возникающей

в вычислительной области, к подробному анализу методов ее решения.

Наконец, мы будем благодарны читателям за обратную связь. Как и в любой

книге такого объема, в ней наверняка встречаются ошибки, которые остались

и в печатном варианте. Комментарии и сообщения об ошибках можно присылать

по электронной почте algbook@cs.cornell.edu; пожалуйста, включите в строку темы

слово «feedback».

Краткое содержание

Глава 1 начинается с представления некоторых типичных алгоритмических задач.

Мы начнем с задачи устойчивых паросочетаний, потому что она позволяет обозначить базовые аспекты разработки алгоритмов более конкретно и элегантно, чем

любые абстрактные рассуждения: поиск устойчивых паросочетаний обусловлен

естественной, хотя и сложной практической областью, на базе которой можно

абстрагировать интересную формулировку задачи и неожиданно эффективный алгоритм ее решения. В оставшейся части главы 1 рассматриваются пять «типичных

задач», которые предопределяют темы из оставшейся части курса. Эти пять задач

взаимосвязаны в том смысле, что все они могут рассматриваться как вариации и/

или особые случаи задачи поиска независимого множества; но одна задача может

быть решена при помощи «жадного» алгоритма, другая — методом динамического

программирования, третья — методом нахождения потока в сети, четвертая (собственно задача независимого множества) является NP-полной, а пятая — PSPACEполной. Тот факт, что тесно связанные задачи могут значительно отличаться по

сложности, играет важную роль в книге, и эти пять задач служат ориентирами,

к которым мы неоднократно возвращаемся по мере изложения материала.

Главы 2 и 3 помогают связать материал с учебным курсом CS1/CS2, о котором

говорилось выше. В главе 2 вводятся ключевые математические определения и понятия, используемые при анализе алгоритмов, а также мотивация для их применения. Глава начинается с неформального обзора того, что же следует понимать под

вычислительной разрешимостью задачи, а также концепцией полиномиального

времени как формального критерия эффективности. Затем вопросы скорости

роста функций и асимптотического анализа рассматриваются более формально,

приводится информация по функциям, часто встречающимся при анализе алгоритмов, а также по их стандартным применениям. В главе 3 рассматриваются

базовые определения и алгоритмические примитивы, необходимые для работы

с графами и занимающие центральное место во многих задачах книги. К концу

учебного курса CS1/CS2 студенты реализуют многие базовые алгоритмы теории

графов, но этот материал полезно представить здесь в более широком контексте

Краткое содержание

21

проектирования алгоритмов. В частности, мы рассмотрим базовые определения

графов, методы обхода графов (обход в ширину и обход в глубину) и основные

концепции направленных графов, включая сильную связность и топологическое

упорядочение.

В главах 2 и 3 также представлены многие базовые структуры данных, используемые при реализации алгоритмов в книге; более сложные структуры данных

описаны в последующих главах. Наш подход к структурам данных заключается

в том, чтобы представлять их тогда, когда они потребуются для реализации алгоритмов, описанных в книге. Таким образом, хотя многие структуры данных уже

будут знакомы студентам по курсу CS1/CS2, мы будем рассматривать их в более

широком контексте проектирования и анализа алгоритмов.

В главах 4–7 рассматриваются четыре основных метода проектирования

алгоритмов: жадные алгоритмы, принцип «разделяй и властвуй», динамическое

программирование и нахождение потока в сети. С жадными алгоритмами важно

понять, когда они работают, а когда нет; наше рассмотрение этой темы базируется на способе классификации алгоритмов, используемых для доказательства

правильности работы жадных алгоритмов. Глава завершается обзором основных

применений жадных алгоритмов для поиска кратчайших путей, направленных

и ненаправленных связующих деревьев, группировки и сжатия. Обсуждение

метода «разделяй и властвуй» начинается с обзора стратегий рекуррентных соотношений как границ времени выполнения; затем мы покажем, как знание этих

рекуррентных соотношений может управлять проектированием алгоритмов,

превосходящих прямолинейные решения многих базовых задач, включая сравнение оценок, нахождение ближайших пар точек на плоскости и быстрое преобразование Фурье. Знакомство с динамическим программированием начинается

с интуитивно понятной рекурсии, на которой оно базируется, с последующей разработкой все более и более выразительных формул через приложения, в которых

они естественным образом встречаются. Наконец, мы рассмотрим алгоритмы для

задач нахождения потока в сети; большая часть этой главы будет посвящена разнообразным практическим применениям этих потоков. В том объеме, в котором

потоки в сети рассматриваются в алгоритмических учебных курсах, студенты

часто недостаточно хорошо представляют широкий спектр задач, к которым они

могут применяться; мы постараемся воздать должное их гибкости и представим

применение потоков для распределения загрузки, планирования, сегментации

изображений, а также ряда других задач.

Главы 8 и 9 посвящены понятию вычислительной неразрешимости. Основное

внимание в них уделяется NP-полноте; базовые NP-полные задачи разбиваются на

категории, чтобы помочь студентам в идентификации возможных сокращений при

обнаружении новых задач. Мы дойдем до достаточно сложных доказательств NPполноты, с рекомендациями относительно того, как следует подходить к построению

сложных сокращений. Также будут рассмотрены типы вычислительной сложности,

выходящие за рамки NP-полноты, особенно в области PSPACE-полноты. Эта полезная концепция подчеркивает, что неразрешимость не кончается на NP-полноте;

PSPACE-полнота также закладывает фундамент для центральных понятий из об-

22

Предисловие

ласти искусственного интеллекта (планирования и ведения игр), которые без нее

не нашли бы отражения в рассматриваемой алгоритмической области.

В главах с 10-й по 12-ю рассматриваются три основных метода работы с вычислительно неразрешимыми задачами: идентификация структурированных

особых случаев, алгоритмы аппроксимации и эвристики локального поиска.

Глава, посвященная разрешимым особым случаям, показывает, что экземпляры

NP-полных задач, встречающиеся на практике, могут быть не столь сложны в худших случаях, потому что нередко они содержат структуру, которая может быть

использована при проектировании эффективного алгоритма. Мы покажем, что