Автор: Лукьяница А.А. Шишкин А.Г.

Теги: компьютерные науки изобразительное искусство издательство москва цифровая обработка изображений цифровая обработка видео

ISBN: 978-5-9901899-1-1

Год: 2009

Текст

lalTV ОХХ^П

i*<TtnrwKT пхюлггии видео i.... .... »<.< ><.. ..

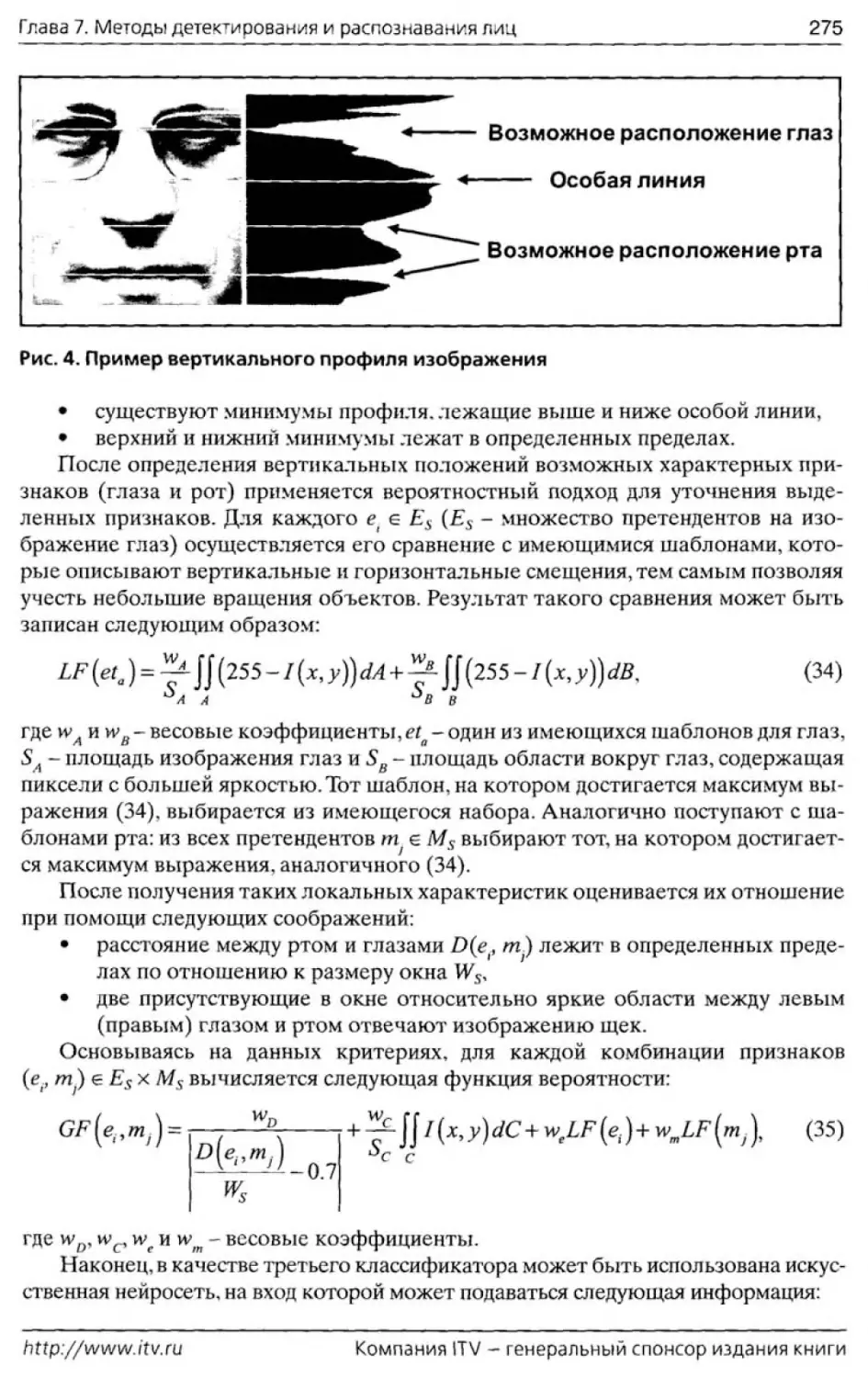

А. А. Лукьяница, А. Г. Шишкин

Цифровая обработка

видеоизображений

А. А. ЛУКЬЯНИЦА, А. Г. ШИШКИН

ЦИФРОВАЯ ОБРАБОТКА

ВИДЕОИЗОБРАЖЕНИЙ

Издательство «Ай-Эс-Эс Пресс»

Москва 2009

Научный рецензент: доктор физико-математических наук, профессор

МГУ имени М. В. Ломоносова. В. Е. Бенинг

Лукьяница Андрей Александрович, Алексей Геннадиевич Шишкин

Цифровая обработка видеоизображений / А. А. Лукьяница,

А. Г. Шишкин. — М.: «Ай-Эс-Эс Пресс», 2009. — 518 с.

ISBN 978-5-9901899-1-1

В настоящее время в нашу жизнь все больше проникает видеоин-

формация, требующая применения специальных методов обработки

и анализа. В книге рассмотрен широкий круг алгоритмов, применяе-

мых для решения важных практических задач: детектирование дви-

жения, отслеживание траекторий, поиск и распознавание объектов

заданных классов, таких как человеческие лица, транспортные сред-

ства, автомобильные номера, дым и огонь. Большое внимание уделено

проблеме поиска разноплановой информации в цифровых видеоархи-

вах. Книга может быть полезна научным сотрудникам, аспирантам и

студентам старших курсов технических ВУЗов, а также всем специ-

алистам в области обработки изображений и распознавания образов.

Редактор Поздняков С. А.

Технический редактор Позднякова М. Е.

Корректор Дикова Е. В.

Компьютерная верстка Малышев А Ю.

Дизайн обложки Лукьяница А. А.

Подписано в печать 29.09.2009. Формат 70x100/16. Тираж 1 000 экз. Отпечатано

в типографии ООО «Ама-Пресс».

ООО «Ай-Эс-Эс Пресс». Москва, ул. Б. Семеновская, 40.

ISBN 978-5-9901899-1-1 © Лукьяница А. А., Шишкин А. Г., 2009

© Оформление. ООО «Ай-Эс-Эс Пресс», 2009

ОТ СПОНСОРА

Современный мир демонстрирует конвергенцию различных сфер де-

ятельности человека. Эта тенденция очень отчетливо прослеживается и

в области видеонаблюдения, куда все более интенсивно проникают ин-

формационные технологии. Видеонаблюдение и охранное телевидение

заимствуют различные компьютерные и сетевые технологии, на осно-

ве которых разрабатываются уже совершенно новые интеллектуаль-

ные алгоритмы, позволяющие расширить функциональность и повы-

сить эффективность систем видеонаблюдения. Эта книга именно о та-

ких алгоритмах.

Конечно, компания ITV, будучи разработчиком программного обе-

спечения для систем безопасности и видсонаблюдения, не могла прой-

ти мимо такого серьезного проекта, каким является издание книги

«Цифровая обработка видеоизображений»... не могла пройти хотя бы

уже в силу специфики своей деятельности. Дело в том, что инновации -

это один из краеугольных камней, на которых выстроено здание на-

шей компании: ITV всегда, с самого основания, была нацелена на вне-

дрение самых передовых технологий. Интеллектуальные алгоритмы

обработки видеоизображений, которые рассматриваются в этой книге,

являются именно такими передовыми технологиями, авангардом раз-

вития современного охранного телевидения и видеонаблюдения. И это

очень важная, хотя и не единственная, причина нашего спонсорства.

Хотелось бы отметить, что материал, изложенный в этой работе,

не ограничивается исключительно сферой охранного телевидения и

видеонаблюдения, как это может показаться на первый взгляд. Дей-

ствительно, видеодетекторы движения, автоматическое распознава-

ние автомобильных номеров, видеодетскторы оставленных и унесен-

ных предметов в первую очередь находят применение в системах ви-

деонаблюдения. Тем не менее, в книге есть главы, которые затрагива-

ют темы, не имеющие непосредственного отношения к сфере видеона-

блюдения. Например, в главе, посвященной автоматическому обнару-

жению дыма и пламени по видеоизображению, разбираются очень пер-

спективные алгоритмы, причем они ближе уже к другим технологиям

безопасности - к пожарной безопасности. А рассматриваемые в послед-

ней главе вопросы индексации видеоизображений и поиска в видеоар-

хивах и цифровых библиотеках выходят далеко за рамки прикладных

задач систем видеонаблюдения.

Конечно, эта книга в первую очередь написана для специалистов в

области распознавания образов и цифровой обработки изображений, а

также для студентов соответствующих кафедр технических институтов.

И все же она не только для них. Уверен, что книга окажется полезна и

многим специалистам индустрии безопасности. Инсталляторы, проекти-

ровщики. консультанты смогут почерпнуть много новой и актуальной с

практической точки зрения информации, необходимой для понимания

принципов, лежащих в основе интеллектуальных алгоритмов современ-

ных систем видеонаблюдения. А это позволит более корректно настра-

ивать и тем самым более эффективно применять на практике интеллек-

туальные функции таких систем.

Эту книгу .можно рассматривать как своего рода учебник по видео-

анализу и в то же время важный фактор, который будет способствовать

повышению уровня знаний и привлечению новых специалистов в отече-

ственную индустрии безопасности. И компания ITV, оказывая спонсор-

скую поддержку изданию самой первой российской книги, посвященной

видеоанализу, преследует именно эти цели.

ПРЕДИСЛОВИЕ

За последние годы в нашей стране был выпущен целый ряд прекрас-

ных книг, посвященных цифровой обработке изображений. Среди таких

работ следует упомянуть Р. Гонсалес, Р. Вудс «Цифровая обработка изо-

бражений», Л. Шапиро, Дж. Стокман «Компьютерное зрение». В. А. Сой-

фер и др. «Методы компьютерной обработки изображений». Д. Форсайт,

Ж. Понс «Компьютерное зрение. Современный подход». Читатель, озна-

комившийся с этими трудами, может получить достаточно полное пред-

ставление обо всех тонкостях цифровой обработки статических изо-

бражений. В последнее время в нашу жизнь отовсюду проникает виде-

оинформация, требующая использования специальных методов анали-

за. Однако до сих пор не существует книг, посвященных обработке ви-

деоизображений. Настоящая монография призвана восполнить образо-

вавшийся пробел. В ней детально рассмотрены все основные этапы тех-

нологии обработки видеоизображений: разнообразные методы постро-

ения модели фона и выделения движущихся объектов, их сегментации и

распознавания, а также отслеживания траекторий. В книге рассматри-

вается широкий круг алгоритмов, применяемых для решения важных

практических задач: детектирование оставленных предметов, выделе-

ние на изображениях объектов заданных классов, таких как человече-

ские лица, транспортные средства, автомобильные номера, очаги дыма

и огня. Большое внимание уделено проблеме осуществления поиска раз-

ноплановой информации в цифровых видеоархивах. Все разделы книги

сопровождаются соответствующими иллюстрациями. В конце приведен

глоссарий для основных использованных понятий.

Предполагается, что читатель знаком с основами цифровой обра-

ботки отдельных изображений. Книга будет полезна научным сотруд-

никам, аспирантам и студентам старших курсов технических ВУЗов, а

также всем специалистам в области обработки изображений и распо-

знавания образов.

А. А. Лукьяница

А. Г. Шишкин

ГЛАВА 1.

ВВЕДЕНИЕ

6

Цифвая обработка видеоизображений

В последние годы существешю возрос интерес к цифровой обработке видеоизобра-

жений, что связано с резким снижением цен на цифровые телекамеры, благодаря чему

они стали доступными широкому’ классу пользователей и начали внедряться во многих

сферах человеческой деятельности для решения задач автоматического контроля и ви-

дсонаблюдсния. И если сначала телекамеры (в дальнейшем мы часто будем называть

их просто камерами) нашли применение в системах охранного телевидения, то вскоре

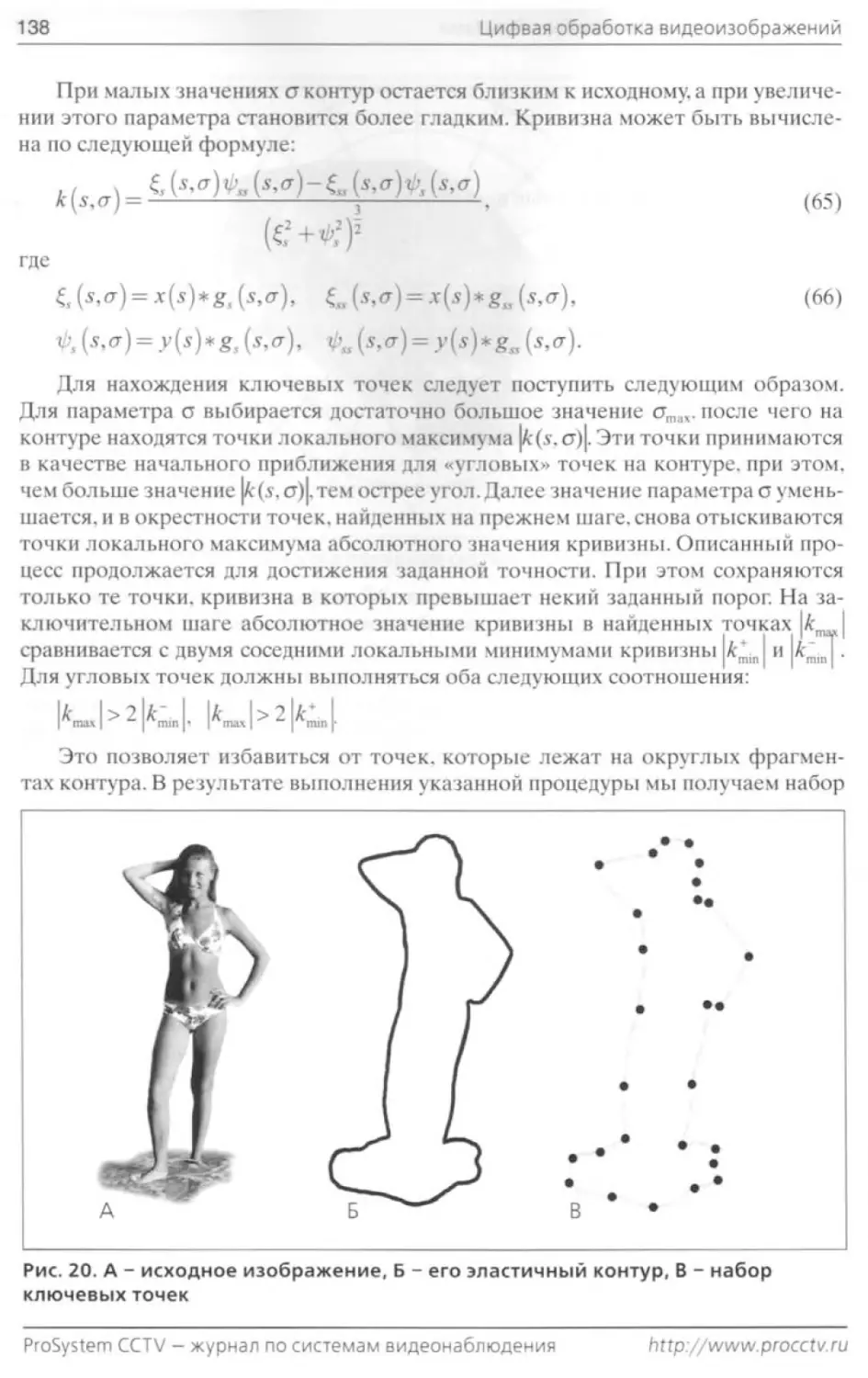

их стали использовать для решения самых разнообразных задач, таких как:

• наблюдение за шоссейными и железными дорогами для предотвращения

аварий,

• измерение скорости автомобилей,

• фиксирование проезда автомобилями перекрестка на запрещающий сигнал

светофора, неправильных перестроений, а также остановки в неположенном

месте,

• автоматическое определение числа занятых и свободных мест на парковках,

• мониторинг банков, гипермаркетов, аэропортов, музеев, вокзалов, парковок

автомобилей,

• осуществление автоматического контроля воздушной обстановки,

• мониторинг урбанизированных территорий, лесных массивов и дачных участ-

ков с целью раннего обнаружения пожаров,

• контроль доступа на охраняемые объекты.

• измерение интенсивности дорожного движения и подсчет числа проехавших

транспортных средств различного класса (легковые автомобили, грузовики,

фуры и т. п.),

• проведение статистических исследований в торговых и развлекательных цен-

трах, а также в музеях,

• бесконтактное наблюдение за животными,

• обнаружение препятствий, возникающих по ходу движения автомобиля,

• подсчет числа изделий на конвейере и первичный контроль качества.

Конечно же, это далеко не полный перечень проблем, которые могут быть

решены путем применения телекамер; мы выделили эти задачи лишь потому, что

авторам в той или иной степени пришлось с ними столкнуться в своей практиче-

ской деятельности.

Одной из наиболее сложных и актуальных задач обработки видеоизображе-

ния является проблема выделения и распознавания движущихся объектов при

наличии различного рода помех и создание на этой основе системы мониторин-

га. Главная задача таких систем - информировать человека о ситуации, сложив-

шейся в поле зрения камеры, и по возможности предпринять какие-либо заранее

предусмотренные и программно заложенные действия.

На первых порах задача сводилась к простому детектированию движущихся

объектов. Уже в таком виде это важно для многих систем безопасности, когда в

охраняемой зоне исключено какое бы то ни было движение. Более совершенные

системы подразумевают наличие в своем составе интеллектуальных видеодетск-

торов движения (которые для краткости мы в дальнейшем будем также назы-

вать прост о детекторами движения), способных отличить движущегося человека

от собаки, машины или дерева, раскачивающегося на ветру. На данный момент

лишь немногие системы безопасности могут похвастаться такими возможно-

ProSystem CCTV - журнал по системам видеонаблюдения

http://www.procctv.ru

Глава 1. Введение 7

стями, существенно их удорожающими. Привлекая внимание к определенному

монитору и автоматически регистрируя произошедшее событие, такие системы

значительно повышают уровень безопасности охраняемого объекта. Кроме того,

видеодстекторы движения часто используются для интеллектуальной компрес-

сии, что позволяет значительно экономить дисковое пространство при архивиро-

вании видеоизображений.

Процесс построения указанных систем представляет собой сложную техно-

логическую цепочку, включающую получение цифрового изображения, его об-

работку с целью выделения значимой информации и анализ этой информации

для решения определенной задачи. Конечно, идеальным представляется создание

универсальной самообучающейся системы, которая в условиях возможных огра-

ничений обеспечивала бы эффективный мониторинг объекта.

Несмотря на то. что в мире создается большое число систем, имеющих различ-

ное предназначение, последовательность обработки видеосигнала в них прибли-

зительно одинакова. Более того, анализ различных систем показал, что в основе

каждой из них лежат практически одни и те же модули. Условно обработку ви-

деоизображений в таких системах можно разделить на следующие этапы:

• выделение переднего плана.

• выделение и классификация движущихся объектов.

• отслеживание траектории движения найденных объектов.

• распознавание и описание действий объектов, представляющих интерес.

Процесс выделения переднего плана заключается в отделении движущихся

фрагментов изображения от неподвижных, которые называют фоновыми или при-

надлежащими заднему плану От того, насколько аккуратно и корректно решена

эта задача, зависят все последующие этапы обработки информации, а также тре-

буемые вычислительные ресурсы. Именно поэтому этапу выделения переднепла-

нового изображения и применяемым для этого методам уделено особое внимание

разработчиков. Сложность этой задачи обуславливается большим количеством

разнообразных факторов, таких как собственные шумы камеры, внезапное измене-

ние освещенности сцены, падающие тени, движение ветвей деревьев на ветру и др.

На втором этапе выделения и классификации сначала производится сегмен-

тация изображения переднего плана, т. е. находятся компактные области, дви-

жущиеся с одинаковой скоростью, которые считаются движущимися объектами.

Далее они соотносятся с заранее определенными классами: автомобили, люди,

животные и т. п.

После этого можно переходить к следующему этапу - отслеживанию траекто-

рии каждого движущегося объекта (этот процесс называется трекингом - от англ,

tracking). Для осуществления трекинга нужно установить взаимно-однозначное

соответствие между обнаруженными объектами на последовательных кадрах.

При этом обеспечивается временная идентификация выделенных областей изо-

бражения и выдается соответствующая информация об объектах в наблюдаемой

зоне, а именно: траектория, скорость и направление движения.

На заключительном этапе обработки проводится распознавание и описание

действий выделенных объектов. В идеальном случае система должна выдавать

сообщения типа: «автомобиль выехал с парковочного места и подъехал к воро-

там», «на перекрестке образовался затор» и т. п.

h 11р. //www. 11 v. г и

Компания ITV - генеральный спонсор издания книги

8

Цифвая обработка видеоизображений

Методам построения переднего плана посвящена Глава 2. Этот этап обработки

видеоряда является наиболее важным, поскольку именно он определяет дальней-

шее качество системы в целом и позволяет значительно сократить объем вы-

числений путем обработки только тех пикселей, которые относятся к переднему

плану. В принятой терминологии считается, что движущиеся объекты принад-

лежат «переднему плану», а стационарные - к «заднему плану», который также

называют фоном. Для построения переднего плана наиболее часто используются

методы, основанные на вычитании фона, вероятностные методы, методы вре-

менной разности и оптического потока.

Методы вычитания фона являются самыми простыми и наиболее часто при-

меняемыми для детектирования движущихся объектов. Суть их заключается в на-

хождении попиксельной разности между* текущим кадром и некой моделью фона.

В принципе, такая модель должна представлять собой сцену без движущихся объ-

ектов. При этом необходимо се регулярное обновление, для того чтобы учитывать

изменение условий освещенности и настроек камеры, таких как поворот, наклон и

изменение фокусного расстояния. Главным недостатком методов вычитания фона

является возможная классификация фоновых пикселей как переднеплановых. Это

может происходить, например, для листьев деревьев, колышущихся на ветру, падаю-

щих снега и дождя, теней, отбрасываемых движущимися объектами и др. Кроме

того, методам данного класса присуща латентность в обновлении модели фона:

должно пройти некоторое время, прежде чем в модели будут учтены изменения,

связанные с началом движения или остановкой объекта. Наконец, методы вычита-

ния фона в своей простейшей реализации предъявляют достаточно высокие требо-

вания к ресурсам вычислительной системы.

В вероятностных методах задний план формируется в результате моделиро-

вания стохастического «пиксельного процесса», т. е. для каждого пикселя изме-

нение его интенсивности от кадра к кадру рассматривается как временной ряд,

состоящий из скалярных величин для полутоновых изображений, и векторов -

для цветных. В результате фон представляет собой гауссову смесь, т. е. линей-

ную комбинацию одномерных, нормально распределенных случайных величин.

Более совершенными являются алгоритмы, создающие поликссльную модель

всей сцены, в которой используются отдельно гауссовы смеси для фона, передне-

го плана и теней. Основываясь на времени существования и дисперсии каждого

гауссиана в смеси, можно определить, какие из них относятся к фону. Пиксели,

значения которых не укладываются в фоновые распределения, считаются перед-

неплановыми до тех пор, пока не появится гауссиан, позволяющий с достаточной

точностью отнести их к фону. Такой подход позволяет учитывать медленные из-

менения освещенности путем подстройки параметров гауссианов. Кроме того, в

рамках вероятностных методов возможен адекватный анализ распределений с

несколькими максимумами, что является типичным для ситуаций с падающими

тенями, отражениями, качающимися ветвями и др. Однако быстрые изменения

фона и освещенности сцены данные алгоритмы описать не могут.

Методы временной разности отделяют передний план от фона при помощи

попиксельного вычитания двух или более последовательных кадров. Очевид-

но, что методы временной разности хорошо определяют динамические измене-

ния сцены, но обычно не могут выделить целиком все однородные пиксели одно-

ProSystem CCTV - журнал по системам видеонаблюдения

http://www. procctv.ru

Глава 1. Введение

Рис. 1. Пример построения модели заднего плана (фона): 1 - методом вычитания

фона, 2 - методом временной разности. 3 - вероятностным методом, 4 - методом,

основанным на нейросети

го объекта, что приводит к фрагментированности выделенных объектов (часто

внутри них образуются пустоты). Кроме того, этим методам не удается обнару-

живать остановившиеся объекты. Поэтому чаще всего методы временной раз-

ности используются совместно с другими методами (например, вероятностными

или вычитания фона), что позволяет им достаточно устойчиво отделять перед-

ний план от фона за небольшое время.

Для выделения переднего плана из видеопоследовательности весьма перспек-

тивным является метод оптического потока. Понятие потока обычно исполь-

зуется для описания когерентного движения точек или характерных признаков

между последовательными кадрами. Выделение фона, основывающееся на вы-

числении оптического потока, использует характеристики вектора потока дви-

жущихся объектов для нахождения тех областей видеопоследовательности, в

которых происходят изменения. Также с помощью оптического потока можно

получить информацию о расположении, размерах и некоторых других параме-

трах таких областей. В принципе, с помощью методов оптического потока может

быть проведено наиболее аккуратное выделение движущихся объектов, даже в

случае перемещения камеры. Однако алгоритмы данного класса являются слиш-

ком ресурсоемкими и. кроме того, чрезвычайно чувствительны к шуму. Вслед-

http://www.itv.ru

Компания ITV - генеральный спонсор издания книги

10

Цифвая обработка видеоизображений

Рис. 2. Результаты обнаружения движущихся объектов для различных моделей

заднего плана (фона): 1 - методом вычитания фона, 2 - методом временной

разности, 3 - вероятностным методом, 4 - методом, основанным на нейросети

ствие этого они на данный момент не могут быть применены к видеопотокам в

реальном времени без дорогих специализированных процессоров.

В настоящее время развиваются методы построения заднего плана, осно-

ванные на применении искусственных нейронных сетей. Эти методы использу-

ют свойство нейронной сети адаптироваться к входным данным за счет введе-

ния настраиваемых обратных связей. Каждый пиксель фона управляется своей

нейронной сетью, в результате чего через некоторое время, требуемое для на-

стройки (обучения) нейронной сети, формируется модель фона, способная за-

данным образом подстраиваться к изменениям входного изображения.

На Рис. I приведен пример выделения фона для одного и того же видеоряда раз-

личными методами. На Рис. 2 представлены результаты выделения движущихся

объектов для тех же самых способов построения модели заднего плана. Видно, что

от качества формирования фона существенно зависит количество найденных дви-

жущихся объектов.

Глава 3 посвящена описанию методов, применяемых для выделения и клас-

сификации движущихся объектов. На видеоизображении могут присутство-

вать различные движущиеся объекты: автомобили, автобусы, мотоциклы, люди,

группы людей, животные и г. п. Основной интерес для систем мониторинга пред-

ProSystem CCTV - журнал по системам видеонаблюдения

h t tp:// w w w. procc t v. ru

Глава 1. Введение

11

Рис. 3. Результаты оконтуривания блобов для различных способов формирования

заднего плана: 1 - методом вычитания фона. 2 - методом временной разности,

3 - вероятностным методом, 4 - методом, основанным на нейросети

ставляют транспортные средства и люди. В большинстве случаев конечной це-

лью видеонаблюдения является выявление нештатных ситуаций, поэтому край-

не важно правильно классифицировать обнаруженные объекты. Так как видео-

наблюдение и анализ ведутся в масштабе реального времени, алгоритмы клас-

сификации должны быть относительно быстрыми, эффективными и инвариант-

ными к изменяющимся условиям освещения.

Методы классификации объектов условно можно разделить на три большие

группы: геометрические методы, методы, основанные на динамических харак-

теристиках движения, и методы, использующие динамические текстуры. Пер-

вые основаны на выделении ряда признаков, характеризующих геометриче-

скую форму объекта, накоплении такой информации за определенный пери-

од времени, создании базы данных многочисленных шаблонов (во время пери-

ода обучения) и сравнении интересующего объекта с шаблонами. К геометри-

ческим методам относятся методы, основанные на сегментировании объектов,

и различные контурные методы. Методы, основанные на динамических харак-

теристиках. используют периодичность процессов, присутствующую практиче-

ски во всех движущихся объектах. Методы, использующие динамические тек-

стуры, являются расширением алгоритмов, основанных на обычных текстурах.

http://www.itv.ru

Компания ITV - генеральный спонсор издания книги

12

Цифвая обработка видеоизображений

и представляют собой одно из наиболее многообещающих направлений в обла-

сти классификации объектов в настоящее время.

Интересующие нас объекты находятся на переднем плане, причем априорно

неизвестно, сколько их, какого они размера, какое имеют взаимное расположе-

ние. Для того чтобы провести классификацию таких объектов, нужно сначала

отделить каждый объект от других, т. е. провести сегментацию изображения.

Результатом этого является либо помеченный набор пикселей переднего плана,

либо указание вершин прямоугольника, внутри которого находится выделенный

объект. В первом случае говорят о выделении так называемого «блоба» (blob -

англ, капля), который задастся набором координат составляющих его пикселей.

Для обработки блобов удобны контурные методы. Выделение описанного пря-

моугольника дает более грубое описание объекта, хотя требует значительно

меньшего времени обработки. На Рис. 3 приведены результаты оконтуривания

блобов для найденных движущихся объектов при различных способах формиро-

вания заднего плана. Из рисунков видно, что огрехи при выделении фона приво-

дят к значительным деформациям контуров и. как следствие, к ошибкам в опре-

делении типа транспортного средства.

Когда объекты хорошо отделимы друг от друга, то даже на основе такой про-

стой характеристики, как отношение высоты к ширине прямоугольника, можно

предварительно определить тип объекта. После проведения сегментирования пе-

реднего плана в большинстве случаев невозможно приступать непосредственно

к классификации объектов. Дело в том, что выделенные блобы обычно имеют

фрагменты, состоящие из отдельных, не связанных пикселей. Кроме того, изо-

бражение часто имеет ряд недостатков в виде мелких областей, линий и отдель-

ных пикселей, не отнесенных ни к какой области.

Существует много различных факторов, которые приводят к таким недостат-

кам в сегментированном изображении. Такие изъяны можно устранить путем

выполнения подходящих морфологических операций дилатации (расширения)

и эрозии. После проведения соответствующей обработки контуры выделенных

сегментов становятся более плавными и содержат минимальное число пустот

внутри объекта.

Однако такая обработка изображения существенно осложняется необходи-

мостью правильного задания конфигурации структурирующего элемента и его

размера. Выбор конфигурации является, в какой-то мере.эмпирическим и интуи-

тивным процессом, а корректный выбор размера структурирующего элемента

для конкретного изображения или его отдельных частей является сложной опти-

мизационной задачей.

Геометрические методы классификации основаны на двух ключевых поняти-

ях: классификационной метрике, позволяющей определить меру близости рас-

сматриваемого объекта и шаблона из имеющейся базы данных, и временной со-

гласованности (классифицируются только те объекты, которые присутствуют в

видеопотоке в течение ряда последовательных кадров, в противном случае они

считаются фоновым шумом). Особую трудность этому придает тот факт, что в

текущем кадре истинная природа объекта может быть искажена вследствие на-

ложения нескольких объектов. Например, группа идущих рядом людей в отдель-

ных кадрах может выглядеть как едущий автомобиль.

ProSystem CCTV - журнал по системам видеонаблюдения

h t tp://w w w. procc t v. ru

Глава 1. Введение

13

Динамические методы основаны на анализе периодичных движений. Свойство

периодичности является весьма распространенным среди движущихся объектов.

Например, у человека во время ходьбы довольно легко можно выделить повто-

ряющиеся через определенное время позы.То же самое относится и к животным.

Поэтому периодичность движения можно использовать для классификации дви-

жущихся объектов.

Особый интерес представляет использование для поставленной задачи динами-

ческих текстур (ДТ). которые являются расширением понятия обычных текстур с

учетом их повторяемости стечением времени.Типичными примерами ДТ служат

видеопоследовательности, изображающие дым.огонь, волны, листву колышущую-

ся на ветру и др. Сферы применения ДТ во многом схожи с таковыми для обычных

текстур - это детектирование, сегментация, распознавание объектов и индексация

изображений для цифровых видеоархивов. Однако использование и анализ ДТ от-

личаются от обработки традиционных статичных текстур. Связано это в первую

очередь с появлением дополнительного измерения, в качестве которого выступает

время. Помимо этого, многие ДТ, такие, например, как дым, довольно трудно сег-

ментировать вследствие того, что их границы непрерывно меняются и плохо раз-

личимы. ДТ могут быть частично прозрачными, что предполагает решение задачи

отделения текстуры от фона. Кроме того, категории при классификации ДТ гораз-

до более расплывчаты и нечетки по сравнению с традиционными текстурами.

Глава 4 посвящена алгоритмам слежения за объектами, или. как их еще на-

зывают, алгоритмам сопровождения объектов, или трекинга. Целью трекинга

является установление соответствия между объектами в последовательности

кадров, а также определение их траекторий и скорости движения. Сопрово-

ждение выделенных объектов в видеопотоке представляет собой чрезвычайно

сложную задачу вследствие влияния следующих факторов:

• изменения изображения, освещенности сцены, наличия шума камеры,

• присутствия меняющих форму объектов.

• наличия нескольких одновременно движущихся объектов с близкими харак-

терными признаками и пересекающимися траекториями,

• неправильной сегментации объектов на предыдущих этапах обработки,

• необходимости осуществлять слежение в масштабе реального времени.

Ошибочное выполнение операции трекинга приводит в дальнейшем к некор-

ректной интерпретации действий анализируемых объектов. Поскольку трекинг

объектов должен часто проводиться в реальном времени, необходимо использовать

алгоритмы, которые не слишком требовательны к вычислительным ресурсам.

Выбор алгоритма трекинга существенным образом зависит от способа пред-

ставления объектов. Обычно используются следующие описания:

• точечный объект, т. е. объект, который представляется одной точкой, обыч-

но являющейся центром масс объекта либо центроидом блоба;

• совокупность характерных точек, по которой можно однозначно распознать

объект на соседних точках;

• геометрический примитив, например эллипс или прямоугольник, описанный

вокруг объекта;

• внешний контур объекта;

• набор движущихся областей;

http://www itv.ru

Компания ITV - генеральный спонсор издания книги

14

Цифзая обработка видеоизображений

• инвариантные характеристики, такие как текстуры, статистические момен-

ты и т. п.

При трекинге точечных объектов существует несколько разновидностей ал-

горитмов: модели трекинга отдельных точек, групп точек и модель глобального

движения, в которой учитывается движение всей совокупности точек на всех рас-

сматриваемых кадрах. Для каждой из моделей вводятся различные ограничения

и целевые функции, из которых формируются так называемые «функционалы

стоимости». В процессе минимизации построенных функционалов устанавлива-

ется наилучшее соответствие между объектами на соседних кадрах. Для сокраще-

ния времени при оптимизации чаще всего применяются локально-оптимальные

алгоритмы. В этих алгоритмах, вместо того чтобы находить оптимальные пути

на всей последовательности кадров, находятся пути, оптимизирующие целевую

функцию для каждой последовательной пары кадров. Замена объекта геометри-

ческим примитивом, эллипсом или прямоугольником, позволяет построить до-

вольно эффективный алгоритм сопровождения. При этом на каждом шаге нужно

подстраивать всего несколько параметров, определяющих положение и форму

примитива. Такой способ трекинга удобен при слежении за хорошо разделимыми

объектами, например за положением головы при проведении видеоконферен-

ции. Методы, основанные на описании контуров объектов, используют в своей

работе динамически обновляемые кривые, ограничивающие область движуще-

гося объекта. Эти методы считаются наиболее устойчивыми как к изменению

освещения, так и к наличию шумов в исходном изображении. Наиболее широко

на практике применяется метод выделения активного контура, который обычно

называют змейкой. Форма контура, задаваемого в параметрическом виде, опре-

деляется из условия минимизации специально сконструированного функционала

энергии. При слежении за движущимися областями удается построить систему

работающую в широком диапазоне скоростей, с которыми движутся объекты.

Единственным недостатком этого подхода являются сравнительно высокие тре-

бования к вычислительным ресурсам, хотя существует ряд специальных алгорит-

мов, позволяющих существенно сократить объем вычислений. Для отождествле-

ния найденных областей на соседних кадрах могут быть использованы различные

инвариантные характеристики, такие как текстуры, статистические моменты,

главные компоненты и др. В результате можно добиться не только инвариант-

ности относительно изменения масштаба и поворотов, но также до некоторой

степени решить проблему частичного загораживания объектами друг друга. В

завершении главы рассмотрено большое число практических алгоритмов, осно-

ванных на использовании различных наборов характерных признаков, за счет

чего удается существенно повысить качество трекинга.

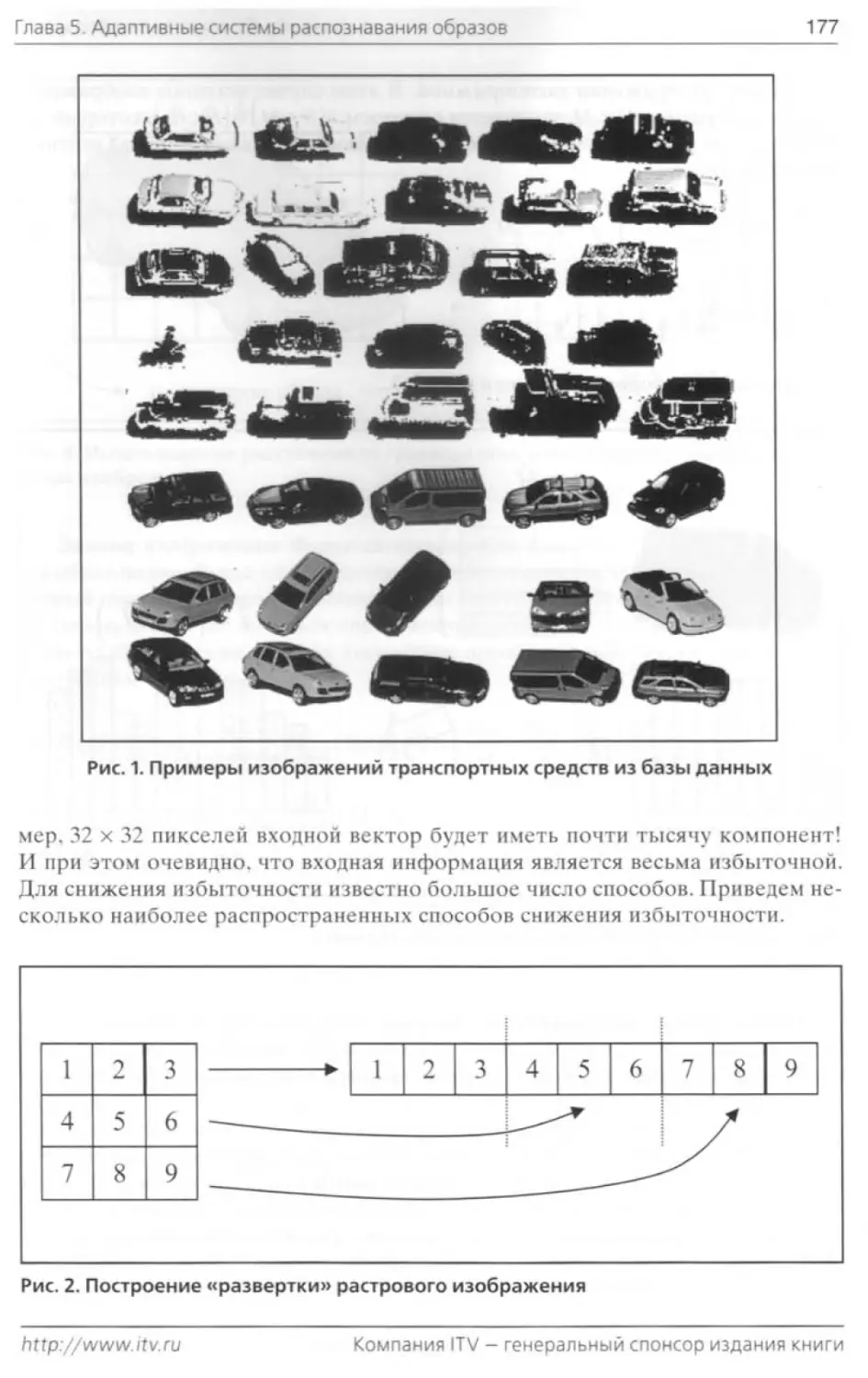

Глава 5 посвящена современным адаптивным методам распознавания образов

и классификации. Использование описанных методов в системе видеонаблюде-

ния позволяет придать ей законченный вид, поскольку на всех этапах обработки

видеоряда,описанных выше, получается, как правило, набор характерных призна-

ков, на основе которых можно распознать обнаруженные объекты. И только в са-

мых простых системах эта задача решается сравнением с известными шаблона-

ми либо вычислением корреляций, что для реальных задач не позволяет получить

высокого процента верно распознанных объектов. Сложность задачи распознава-

ProSystem CCTV - журнал по системам видеонаблюдения

h t tp://www. procctv. ru

'лава 1. Введение

15

ния состоит в том, что, как правило, характерные признаки являются многомер-

ными векторами, в совокупности описывающими некоторые свойства рассматри-

ваемых объектов, например: гистограммы, набор моментов, текстур и т. п . И чрез-

вычайно неприятным является то обстоятельство, что сами характерные призна-

ки весьма изменчивы и для различных объектов из одного и того же класса мо-

гут существенно отличаться. Рассматриваемые в Езаве 5 методы являются адап-

тивными, т. е. способными к автоматической подстройке к свойствам обрабаты-

ваемых данных, что в итоге позволяет разработать распознающую систему с не-

плохими характеристиками. В первом разделе главы приводятся различные ме-

тоды для подготовки исходных данных к некому стандартному виду, пригодному

для настройки адаптивной системы. Традиционно процесс подготовки данных за-

ключается в их разбиении на входные и выходные с последующей нормализаци-

ей. Входные данные подаются на вход системы, в то время как выходные данные

используются как эталон, который адаптивная система должна в идеале выдавать

в качестве результата, например номер класса, к которому должны быть отнесе-

ны входные данные. В Отаве 5 рассматриваются следующие разновидности адап-

тивных методов:

• искусственные нейронные сети.

• метод опорных векторов,

• методы кластеризации данных.

• методы бустинга.

Искусственные нейронные сети появились в результате попыток моделиро-

вания процессов распознавания мозгом живых существ, поэтому даже терми-

нология. применяемая в этой области, частично заимствована из биологии. В

разделе рассматриваются два наиболее часто применяемых типа нейросетей:

прямого распространения (персептрон) и нейросеть с нейронами радиального

базиса. Большое внимание уделено организации процесса настройки нейросети,

поскольку он, как правило, вызывает большие затруднения даже у квалифициро-

ванных специалистов.

Метод опорных векторов был предложен отечественными учеными В. Вап-

ником и А. Червоненкисом. В иностранной литературе он известен как Support

Vector Machine (SVM). Метод опорных векторов основан на идее построения

оптимальной гиперплоскости, разделяющей два множества. Основное структур-

ное отличие SVM от нейросетей заключается в том, что для нейросети количе-

ство настраиваемых коэффициентов должно априорно задаваться пользовате-

лем на основании некоторых эвристических соображений. В случае применения

SVM количество настраиваемых параметров автоматически определяется во

время настройки и обычно существенно меньше, чем число векторов в обучаю-

щей последовательности. Отличными от нуля остаются только коэффициенты

при так называемых опорных векторах, с помощью которых и строится разде-

ляющая гиперповерхность.

Методы кластерного анализа используются для решения задачи, в которой

требуется разбить заданную выборку объектов на непересекающиеся подмно-

жества, называемые кластерами, так, чтобы каждый кластер состоял из схожих

объектов, а любые два объекта, принадлежащие разным кластерам, существен-

но отличались. Процесс построения кластеров принадлежит к разряду адаптив-

-:tp://www.itv.ru

Компания ITV - генеральный спонсор издания книги

16

Цифвая обработка видеоизображений

ных алгоритмов, однако, в отличие от ранее рассмотренных нейросетей и мето-

да опорных векторов, он относится к классу методов обучения «без учителя».

Это означает, что в примерах, используемых при обучении, присутствуют только

входные данные и отсутствует какая-либо информация об их принадлежности к

тому или иному классу.

Методы бустинга (от англ, boosting - повышение, усиление) предназначе-

ны для повышения качества распознающей системы за счет использования набо-

ра экспертов, которых также называют «элементарными распознавателями», или

классификаторами. В качестве эксперта может выступать любая распознающая

система, например основанная на применении искусственной нейронной сети. Не-

обходимым требованием к эксперту является только одно: он должен обладать до-

стоверностью распознавания не менее 50%. Линейная комбинация из набора та-

ких экспертов, обученных соответствующим образом, может достигать надежно-

сти распознавания, близкой к 100%’. В разделе рассмотрено несколько методов бу-

стинга, применяемых для разделения как двух, так и произвольного числа классов.

Следующие главы книги посвящены решению различных прикладных задач,

которые возникают при разработке систем видеонаблюдения. В Главе 6 рассма-

триваются алгоритмы для обнаружения и детектирования оставленных объектов.

Интерес к этой задаче особенно возрос в последние годы в связи с проблемой мо-

ниторинга мест скопления людей (аэропорты, супермаркеты, вокзалы и др.) с це-

лью предотвращения террористических актов. Сложность задачи заключается в

том, что обычно не существует даже приблизительной априорной информации о

предмете, который может быть оставлен, и, кроме того, этот предмет обычно вре-

менами перекрывается (например, проходящими людьми). В Главе 6 рассмотрены

различные алгоритмы, начиная со статистических, позволяющих построить спе-

циальный детектор оставленных предметов, и заканчивая более сложными, осно-

ванными на использовании уже работающих блоков сопровождения движущихся

объектов. В последнем случае оставленный предмет может быть определен как

некий объект, внезапно появившийся на переднем плане, либо скорость движе-

ния которого стала равной нулю. Отметим, что рассматриваемые алгоритмы мо-

гут также быть использованы и для обнаружения унесенных (похищенных) пред-

метов, для детектирования припаркованных автомобилей, обнаружения транс-

портных средств, остановившихся в туннеле, выявления посторонних объектов на

взлетно-посадочной полосе и для решения других подобных задач.

[лава 7 посвящена проблеме детектирования и локализации лиц на видеоизобра-

жениях. Начиная с семидесятых годов прошлого века, задаче распознавания лиц на

изображениях всегда уделялось большое внимание. Однако в последнее десятиле-

тие эта область переживает настоящий бум, связанный с возрастающим с каждым

годом числом возможных приложений и появлением новых технологий и методов

решения указанной проблемы. Несмотря на достигнутые успехи, надежное распо-

знавание лиц на изображениях, полученных вне помещений, а также с меняющи-

мися условиями освещения и угла поля зрения, представляет собой до сих пор нере-

шенную задачу.

Большинство существующих в этой области работ относится ко второму этапу

данной проблемы - непосредственно к самому распознаванию. Первому, не менее

важному этапу, - детектированию и выделению лиц - уделено значительно мень-

ProSystem CCTV - журнал по системам видеонаблюдения

http://www.procctv.ru

Глава 1. Введение

17

шс внимания. В целом, эта задача может быть сформулирована следующим обра-

зом: в данном кадре видеопоследовательности определить наличие или отсутствие

лиц людей и при положительном ответе найти границы прямоугольных рамок, це-

ликом включающих лица. При этом решение указанной проблемы должно быть

инвариантным к изменениям условий освещенности, масштаба и ориентации. По-

строение системы, отвечающей перечисленным требованиям, представляет собой

чрезвычайно сложную задачу*. Причем в случае обработки не статических изобра-

жений. а видеоизображения существует ряд факторов, существенно усложняющих

анализ. Во-первых, это низкое качество видеоизображения и наличие во многих

случаях объектов, частично перекрывающих лица. Во-вторых, размеры лиц на ви-

деоизображениях обычно значительно меньше, чем на фотоснимках.

Первые попытки решить поставленную задачу заключались в использовании

простых алгоритмов сравнения последовательных кадров, основываясь на их

попикссльном сопоставлении. Естественно, что при наличии нескольких движу-

щихся объектов и их взаимных перекрытий данный класс алгоритмов является

неэффективным. Поэтому в последующих методах для сегментации лиц на ви-

деоизображениях стали активно использовать потоковую (относящуюся к дви-

жению). а также цветовую информацию. Это позволило значительно улучшить

качество выделения лиц. При этом обычно выделяются границы не самого лица,

а только прямоугольника, его содержащего. После этого, как правило, применя-

ются методы, разработанные для анализа статических изображений.

После выделения лица на изображении можно непосредственно переходить к

его распознаванию. И здесь исторически первыми появились методы, разработан-

ные для отдельных изображений. К ним. в первую очередь, следует отнести ме-

тод построения «собственных лиц» (eigenfaces), основанный на выделении глав-

ных компонент изображения; метод построения и сравнения специальных графов

j elastic graph matching); различные варианты метода бустинга и др. Хотя, как и для

задач выделения лиц, для закрытых помещений с постоянным освещением и ма-

лым числом людей здесь достигнуты значительные успехи, в случае распознава-

ния на открытых пространствах при меняющейся освещенности сцены до сих пор

существует ряд проблем, препятствующих полному и надежному решению зада-

чи. Поэтому большие надежды в настоящее время возлагаются на использование

когерентности временной информации, содержащейся в видеопоследовательно-

сти. Тем более что, как известно из области психофизиологии, человек значитель-

но лучше распознает лица людей на видеоизображениях, чем на отдельных изо-

бражениях. Среди методов, использующих для распознавания временную согласо-

ванность отдельных кадров, можно выделить построение идентифицирующих по-

верхностей (identity surfaces) и использование широко и успешно применяющегося

для решения и других задач метода конденсации (condensation algorithm).

Во многих ситуациях возникает необходимость распознавать транспортные

средства и на статических изображениях. Действительно, когда автомобиль по-

падает в дорожный затор и перестает двигаться, то через некоторое время он бу-

дет сегментирован в объект фона. Аналогичная сложность возникает и при раз-

работке системы автоматической парковки, поскольку большую часть времени

автомобили являются неподвижными, а потому невидимыми для детектора дви-

жения. Проблеме распознавания объектов заданного класса, в первую очередь,

~ttp://www.itv.ru

Компания ITV - генеральный спонсор издания книги

18

Цифвая обработка видеоизображений

разнообразных транспортных средств, посвящена Гзава 8. Основная трудность

при обнаружении и локализации объектов на изображении заключается в видо-

вом многообразии объектов и сильной внешней изменчивости одного и того же

объекта при наблюдении его в разных условиях. Существует большое число ме-

тодов для обнаружения и распознавания объектов на статическом изображении.

При этом обычно на изображении выделяются области, обладающие свойства-

ми, характерными для исследуемых объектов, и производится их проверка для

выявления областей, релевантных поставленной задаче. Сущность этой провер-

ки зависит от характера используемых признаков и может быть основана на не-

котором эмпирическом алгоритме, на статистике взаимного расположения при-

знаков, собранной по изображениям транспортных средств, на моделировании

процессов, происходящих в мозгу человека при распознавании визуальных обра-

зов. на применении шаблонов различного рода и т. д.

В принципе, для детектирования и локализации транспортных средств могут

быть использованы многие методы из предыдущей главы. Однако существу-

ет ряд особенностей рассматриваемой задачи, которые приводят к разработке

алгоритмов, специфичных только для выделения транспортных средств. В Гла-

ве 8 рассмотрены современные методы, хорошо зарекомендовавшие себя для

решения поставленной задачи: статистические методы, использование много-

масштабных текстур, а также применение всевозможных классификаторов и

повышение достоверности распознавания за счет методов бустинга, т. е. орга-

низации системы «экспертов», качество работы которой существенно превос-

ходит способности отдельных экспертов.

Втава 9 посвящена имеющей давнюю историю проблеме автоматического

распознавания регистрационных номеров автомобилей. Еще в 1976 г. научно-

исследовательский отдел Управления полиции Великобритании начал разработку

системы для считывания с помощью телекамеры и последующего анализа номер-

ных знаков автомобилей. В 1979 г. такая система была создана, и уже в 1981 г с ее

помощью был задержан подозреваемый в угоне автомобиля. В настоящее время

системы автоматического распознавания номерных знаков находят самое широ-

кое применение, начиная от сбора пошлины на пропускных пунктах автодорог и

контроля дорожной обстановки и заканчивая выявлением угнанных автомобилей.

Как правило, распознавание регистрационных номеров автомобилей прово-

дится по следующей схеме. На первом этапе, являющемся основой эффективной

и надежной работы всей системы, производится обнаружение и сегментация но-

мерного знака на видеоизображении. Решение данной задачи осложняется низ-

ким качеством имеющихся изображений, резкой сменой освещенности объектов,

наличием на изображении нескольких знаков, а также букв и цифр, не относя-

щихся к искомым регистрационным номерам, большим разнообразием номер-

ных знаков, перспективными искажениями, загрязненностью номеров. Кроме

того, выделенная область в большинстве случаев не является ориентированной

строго горизонтально. Если не осуществлять ее поворота на данном этапе, то в

дальнейшем это может сказаться на результатах работы всей системы.

Второй этап состоит в сегментации отдельных букв и цифр на выделенном но-

мерном знаке. Наиболее простой и быстрой процедурой здесь является построение

вертикальной проекции предварительно приведенного к бинарному виду номер-

ProSystem CCTV — журнал по системам видеонаблюдения

http://www.procctv.rij

лава 1. Введение

19

ного знака. Отметим, что данный класс алгоритмов в большой степени подвержен

влиянию шумов, всегда присутствующих на изображениях. Помимо этого, на дан-

ном этапе широко применяются методы, основанные на анализе областей.

Третий (и последний) этап в работе рассматриваемых систем заключается в

непосредственном распознавании сегментированных на номерном знаке букв и

цифр. Данная задача полностью укладывается в рамки давно исследуемой обла-

сти по оптическому распознаванию символов. В целом, все существующие для

этого методы либо используют базы данных из предварительно построенных

^шаблонов. либо основаны на применении адаптивных распознающих систем.

В Главе 10 рассматриваются методы детектирования огня и дыма по видео-

изображению. При возникновении очага возгорания минимальная латентность

з детектировании данного события чрезвычайно важна, так как это позволяет

уменьшить ущерб от пожара, а в ряде случаев и спасти человеческие жизни. Все

современные детекторы дыма фиксируют наступление критического события

только после того, как частицы дыма достигнут точки расположения сенсора.

При этом в помещениях с направленной вентиляцией (туннели, шахты), а также

с типичной стратификацией воздушных слоев (ангары.склады) на это может по-

требоваться довольно много времени. Па открытых пространствах методы хими-

ческого анализа вообще бесполезны. Таким образом, детектирование дыма с по-

:эщью видеопоследовательности обладает рядом преимуществ по сравнению с

~гхдиционными методами:

• возможность обнаружения дыма и огня на открытых пространствах и в тун-

нелях.

• точное определение местоположения очага возгорания и степени распро-

странения пламени,

• минимальная реакция на возникновение нештатной ситуации.

Ясно, что разработка подобной системы имеет большие перспективы. Дей-

."лтельно, по данным МЧС, появившимся в прессе в апреле 2007 года, ежеднев-

з России происходит в среднем 558 пожаров, на которых погибают 55 человек

3> человек получают травмы. Ежедневный материальный ущерб от пожаров

. ставляет 22.7 млн. руб.

К сожалению, вследствие ряда причин детектирование дыма и огня по видеои-

'ражению пока еще уступает с точки зрения эффективности традиционным

годам. Это объясняется следующими обстоятельствами:

• большие разнообразие и изменчивость плотности дыма, заднего плана и

условий освещения.

• ни один из таких простейших характерных признаков, как интенсивность,

движение, краевые точки не позволяет достаточно полно описать дым,

• сложность создания визуальной модели дыма.

Тем не менее, в последние годы были разработаны методы и алгоритмы, по-

.тяющие значительно увеличить надежность соответствующих видеосистем

.“актирования. Это привело к созданию нескольких успешно работающих ком-

.гческих систем.

Ттава 11 посвящена проблеме индексации видеоизображений и поиску в циф-

-ых библиотеках и архивах видеоданных. Повсеместное распространение ви-

. “ехнологий и развитие компьютерной техники привело к тому, что цифровые

www.itv.ru

Компания ITV - генеральный спонсор издания книги

20

Цифвая обработка видеоизображений

архивы видеоинформации стали неотъемлемой частью самых разных систем.

Однако методы поиска в этих огромных хранилищах данных остаются весьма

примитивными и явно не отвечают современным требованиям. Обычно системы

управления цифровыми видеоархивами состоят из двух частей. Функции первой

из них заключаются в анализе поступающей видеоинформации, ее сегментации

на отдельные более мелкие фрагменты и индексации, основанной на содержании

этих фрагментов. Вторая часть системы позволяет извлекать необходимые дан-

ные в зависимости от запроса пользователя и организует взаимодействие с ним.

Большинство существующих в настоящее время систем базируется на различ-

ных текстовых аннотациях содержимого. В простейшем случае это могут быть

подписи к кадрам, ключевые слова или даже имена файлов. Очевидно, что в том

случае, когда необходимо отыскать определенный объект или событие в длинной

видеопоследовательности, методы, использующие текстовые аннотации, являются

бесполезными. Более того, для ряда объектов в принципе невозможно подобрать

лаконичное, но в то же самое время адекватное текстовое описание. Поэтому бо-

лее совершенные системы используют для индексации видеоинформации комби-

нацию нескольких характерных признаков, которые объединяются в вектор боль-

шой размерности. Эти векторы затем сохраняются в базе данных. Данные призна-

ки могут быть как низкоуровневыми (примитивными), так и высокого уровня (се-

мантическими). Когда от пользователя поступает запрос, то начинается просмотр

всей или части указанной базы данных и в качестве результатов поиска выдается

несколько кадров, ранжированных в соответствии с мерой их схожести с запросом.

Для формирования векторов характерных признаков в видеопоследовательност и

производится ее сегментация и выделяются или ключевые кадры, в большинстве

случаев отмечающие начало или конец какого-либо события, или ключевые объ-

екты. В зависимости от типа архива с этой целью могут быть использованы различ-

ные методы, некоторые из которых изложены в Птаве 11. Отметим, что в отличие

от предыдущих разделов книги методы данной главы не рассчитаны на исполнение

в режиме реального времени, что позволяет снять ряд весьма жестких ограничений.

Каждая глава имеет независимую нумерацию иллюстраций, формул и списка

использованных источников. При описании различных алгоритмов, предназна-

ченных для решения задач одного класса, мы старались расположить их по воз-

растанию сложности.

Вследствие того, что для ряда устоявшихся англоязычных терминов и поня-

тий в отечественной литературе до сих пор не существует соответствующих эк-

вивалентов, авторы взяли на себя смелость использовать или собственные рус-

скоязычные аналоги, или те. которые достаточно активно используются в среде

разработчиков методов и программ анализа видеоизображений. Для того чтобы

у читателя, знакомого с иностранными работами по обработке видеоизображе-

ний, в этом случае не возникло вопросов по ходу прочтения книги, мы добавили

специальный раздел (глоссарий), где приведены основные термины с их опреде-

лениями и англоязычными аналогами.

Несмотря на то. что мы тщательно выверяли материал книги, в работе такого

объема могут остаться ошибки. Авторы будут весьма признательны читателям,

которые сообщат о найденных неточностях. Отзывы и замечания просьба направ-

лять по адресу: book2008@ic.msu.su.

ProSystem CCTV - журнал по системам видеонаблюдения

http://www.procctv.ru

ГЛАВА 2.

ПОСТРОЕНИЕ МОДЕЛЕЙ ФОНА И

ВЫДЕЛЕНИЕ ПЕРЕДНЕГО ПЛАНА

24

Цифвая обработка видеоизображений

При обработке видеоизображений появляется возможность отделить движу-

щиеся объекты от неподвижных. Заметим, что для систем мониторинга как раз

движущиеся объекты и представляют основной интерес. При этом всю совокуп-

ность неподвижных объектов называют фоном или задним планом, в отличие от

которых движущиеся объекты часто называют переднеплановыми. Задача вы-

деления фона является довольно непростой, поскольку на изображениях, полу-

чающихся в реальной видеосъемке, отсутствуют абсолютно нс изменяющиеся

фрагменты. Это связано как со свойствами реальных камер, которые обладают

довольно заметными собственными шумами, так и тракта передачи видеоинфор-

мации от камеры к системе обработки, в котором изображение перед пересыл-

кой часто сжимается, а потом декодируется, что может привести к дополнитель-

ным искажениям сигнала. Более того, на сцене часто присутствуют объекты,

которые хоть и являются в нашем понимании неподвижными, однако обладают

определенными динамическими характеристиками (например, деревья, качаю-

щиеся на ветру). Учет перечисленных факторов при выделении фона приводит

к необходимости разработки довольно гибкой системы, которая, как принято го-

ворить, формирует модель заднего плана.

При построении модели заднего плана следует в той или иной степени учи-

тывать свойства объектов, которые могут присутствовать на видеоизображении.

Эти объекты можно разбить на следующие группы:

• неподвижные объекты,

• временно неподвижные объекты,

• медленно движущиеся объекты,

• объекты, совершающие периодические колебания,

• неподвижные объекты с динамически меняющимся изображением,

• движущиеся объекты.

К неподвижным объектам относятся различные стационарные объекты,

такие как сооружения, покрытие дорог, столбы и т. п., т. е. все объекты, ко-

торые являются неподвижными в течение достаточно длительного периода

времени. Временно неподвижными объектами являются запаркованные авто-

мобили, ограждения при дорожных работах и т. п., т. е. объекты, являющиеся

неподвижными во временном диапазоне от нескольких минут до нескольких

дней. К медленно движущимся объектам относятся автомобили, находящиеся

в дорожной пробке, тени от облаков и зданий, т. е. объекты, все время находя-

щиеся в движении, которое практически невозможно различить на большин-

стве соседних кадров при регистрации камерой. Объектами, совершающими

периодические колебания, являются деревья и кусты, флаги, рекламы на пере-

тяжках, т. е. объекты, которые периодически перемещаются около некоторо-

го положения равновесия, как правило, под действием ветра. К неподвижным

объектам с динамически меняющимся изображением относятся световые ре-

кламные табло, огни светофоров и аварийно припаркованных автомобилей и

т. п. Эти объекты находятся на одном месте (т. е. не движутся), однако создава-

емый ими световой поток достаточно быстро изменяется во времени. И, нако-

нец, движущиеся объекты - это всевозможные транспортные средства, иду-

щие и бегущие люди, животные, тени от них, т. е. все то, что перемещается с

достаточно заметной скоростью.

ProSystem CCTV - журнал по системам видеонаблюдения

http://www.procctv.ru

Глава 2. Построение моделей фо*а и выделение переднего плана

25

Еще раз заметим, что обнаружение движущихся объектов, или иначе выделе-

ние переднего плана, является самым важным элементом системы мониторинга.

От того, насколько аккуратно и корректно выделены движущиеся объекты, за-

висят все последующие этапы, а также требуемые вычислительные ресурсы. Все

методы, которые были разработаны к настоящему моменту, можно разделить на

следующие группы:

• методы вычитания фона.

• вероятностные методы.

♦ методы временной разности.

• методы оптического потока.

Методы из разных групп имеют различную сложность реализации и, соот-

ветственно, отличаются необходимыми требованиями к вычислительным ресур-

сам. В большинстве случаев задача обработки видсопотока осуществляется в ре-

альном времени, и зачастую на одном компьютере обрабатывается информация,

получаемая одновременно от нескольких камер. Ясно, что при разработке по-

добной системы разработчики отдадут предпочтение более простым методам

вычитания фона в ущерб качеству, нежели методу оптического потока, который

требует достаточно больших ресурсов. В то же время при обработке видеоархи-

вов, (например, для их индексирования), можно применить более сложные мето-

ды, позволяющие достичь лучшего качества обработки.

2.1 МЕТОДЫ ВЫЧИТАНИЯ ФОНА

Вычитание фона - это наиболее широко распространенный в настоящее вре-

мя подход к обнаружению движущихся объектов в видеоизображениях, получен-

ных с помощью стационарной телекамеры. Суть таких методов заключается в

попиксельном сравнении текущего кадра с шаблонным, который обычно назы-

вают моделью фона. Как правило, эта модель, представляющая собой описание

сцены без движущихся объектов, должна регулярно обновляться, чтобы отра-

жать изменения освещенности и геометрических параметров [1-14].

Рассмотрим видеопоследовательность, получаемую со стационарной теле-

камеры. Для каждого кадра этой последовательности нам необходимо постро-

ить двоичную маску изображения, в которой значение 1 соответствует передне-

му плану, а 0 - фону. Обычно считается, что в течение п первых кадров в видео-

последовательности нет движущихся объектов. Это требование необходимо для

корректного построения фоновой модели. Однако оно не всегда может быть вы-

полнено, поэтому вместо него часто рассматривают так называемую динамиче-

скую модель фона, когда считается, что в п первых кадрах могут присутствовать

движущиеся объекты (например, ветви деревьев, колышущиеся на ветру), но они

не представляют интереса для проводимого анализа. На Рис. 1 приведен пример

обработки видеопоследовательности с использованием метода вычитания фона.

Простейший алгоритм вычитания фона заключается в вычислении для

каждого пикселя абсолютного значения разности сохраненного первого кадра

В(х, у) видеопоследовательности и текущего кадра 1(х, у). Полученное значение

сравнивается с порогом <5:

http://www.itv.ru

Компания ITV - генеральный спонсор издания книги

26

Цифвая обработка видеоизображений

Рис. 1. Пример обработки изображения с помощью метода вычитания фона. А - ис-

ходное изображение, Б - двоичная маска, В - модель фона, Г - выделенный перед-

ний план

|В(х,у)-/(х,>)|><5, х = у = (1)

Здесь N и Л/ - соответственно ширина и высота изображения. Если данное нера-

венство выполняется, то пиксель (х, у) считается переднеплановым, иначе - фо-

новым. Для устранения шума можно обновлять задний план с помощью фильтра

с бесконечным импульсным откликом:

Дя=а/,+(1-а)Д, (2)

где индекс t обозначает номер кадра, а а обычно лежит в пределах от 0.05 до 0.15.

Кроме (2) можно использовать другие, несколько более сложные фильтры. На-

пример. пиксели, относящиеся к фоновому изображению, определять из следую-

щего соотношения:

в, (*»>’) = a rg min £|/м (х,у) - (х,у)|. (3)

,=0." /=0

ProSystem CCTV - журнал по системам видеонаблюдения

http://www.procctv.ru

Глава 2. Построение моделей фона и выделение переднего плана

27

Естественно, для этого метода требуется увеличение необходимых вычислитель-

ных ресурсов, так как приходится хранить информацию из п предыдущих кадров.

Вместо неравенства (1) также можно применить следующее неравенство:

I у) ~ Л .у) ”

1 Л -<—'> и > 5, (4)

О'

где и о - среднее значение и стандартное отклонение величины В (х, у)-Цх, у).

Для усиления контрастности в темных областях, таких как тени, иногда ис-

пользуется относительная разница фона и текущего изображения:

|Д(х.>)-/(»,у)|>г (5)

в,(х>у)

Тем не менее, данная модификация алгоритма не будет работать, например, для

изображений, полученных в густом тумане.

Отметим, что единственным достоинством указанных алгоритмов являет-

ся простота их реализации. К недостаткам данных методов относятся высокая

чувствительность к изменению освещенности сцены (при этом большая часть

сцены может быть сегментирована в передний план) и шуму камеры, невозмож-

ность обработки динамического фона, большая вероятность ошибок первого и

второго рода при классификации конкретных пикселей изображения. Одной из

причин этого является постоянство порогового значения 8. В идеале порог дол-

жен быть свой для каждого пикселя. Например, для областей с низкой контраст-

ностью он должен быть меньше. Хотя с помощью варьирования значений пара-

метров фильтрации и порога 8 можно в каждом конкретном случае сократить

число получаемых ошибок, алгоритмы (1)-(5) в указанном виде практически ни-

когда не используются в действующих системах обработки видеоизображений.

Поэтому далее мы будем рассматривать различные модификации простейше-

го метода вычитания фона, позволяющие избавиться от одной или же сразу не-

скольких из перечисленных здесь проблем.

Одним из возможных способов преодоления указанных недостатков, в част-

ности корректного учета изменения освещенности сцены, а также периодиче-

ских фоновых движений (ветви деревьев), при выделении переднего плана яв-

ляется использование двух моделей фона. Предположим, что в момент времени t

имеется первичное фоновое изображение В/ и вторичное В/ (х,у). Соответ-

ственно можно получить две разности фона и текущего изображения:

(*. у) = \в? (х*у)~ Л (х»у)|. (6)

D< (х> у)-Iй/ (*» у) - Л (*> у)|- <7)

Обозначим через q тот индекс (р или $), для которого указанная выше разность

Dt меньше, а через q- другой индекс. Тогда обновление фоновых изображений

проводится по следующей схеме:

(1-а')Вг’(х,^) + а7((х,у), (x,y)eFG,

1(1 - а) В,’ (х, j) + al, (х, у), (х, е BG,

(*,у)

http://www.itv.ru

Компания ITV - генеральный спонсор издания книги

28

Цифвая обработка видеоизображений

В^х,у) = В'(х,у). (9)

Здесь FG и BGt обозначают области изображения, относящиеся к передне-

му плану и фону в момент времени t соответственно. Обычно а' выбирают мень-

ше, чем а, а для инициализации фоновых изображений в качестве Btp(x,y) ис-

пользуются средние значения для нескольких первых кадров. При этом величи-

на В/ (х,у) определяется как

В;(х,у) = В1р(х,у) + и(х,у). (10)

где функция и (x,j>) описывает шум. присутствующий в изображении.

Другим возможным улучшением простейшего алгоритма вычитания фона

является адаптивное определение величины порога, что, в принципе, можно осу-

ществлять различными способами. Например, можно сначала рассчитать раз-

ность фона и текущего изображения:

D(x,y) = |s(x,^)-7(x,jy)|, (11)

а затем для нес построить гистограмму

0.

D(x,y) = k

D(x,y)* к

(12)

где Л=0,...255. Найдем значение /и, при котором достигается максимум,

S = max Н (к\Тогда можно найти такое 8. что

Н(8) = Р8т, 8 > arg max Н {к\ (13)

к

Для параметра Д рекомендуется выбирать небольшое значение, порядка

0,05. Далее при определении фона применяется следующая схема. Для перво-

го кадра фон считается совпадающим с текущим изображением и вычисляется

маска

Л/(х,^) =

1,

о,

D(x,y)>8

D(x,y)<8

(14)

Для всех пикселей, для которых М(х, у)=0,фон обновляется по формуле (2).

При этом в случае меняющегося освещения или изменения положения камеры

будут появляться области изображения, для которых М(х, у)=1 на протяжении

многих кадров (например, движение тени от стационарного объекта). Для устра-

нения этого недостатка проводится подстройка маски:

Ч (^>')=-’(Ч-я (^.^)& Ч-я+1 (х,у)&...& М, (x,j))

где п - наперед заданное количество кадров. Аналогично для всех пикселей, для

которых М (х,^) = 0, фон меняется по формуле (2).

Помимо величины порога 5, можно также адаптивным образом изменять и

фоновую модель. При этом существенное изменение внешних условий,таких как

смена дня и ночи, учитываются при помощи адаптивной схемы в зависимости от

ProSystem CCTV - журнал по системам видеонаблюдения

h t tp://www. ргосс tv. г и

Глава 2. Построение моделей фона и выделение переднего плана

29

того, является ли рассматриваемый пиксель переднеплановым ((x,y)eFG) или

фоновым G BG):

аВ, (х, _у) + (1 - а) /, (х, у), (х, у) 6 BG

рВ, (х, у) + (1 - Д) I, (х,у), (х,у) е FG

(15)

«4 (^.^)+(1 - «)(Y |Л См’)- в.

(х,у)е BG

(х,у)е FG.

(16)

Здесь а,Р е [0,1] и у - весовые коэффициенты, определяющие степень об-

новления фона и порога S. Как видно из приведенных формул, в данном методе

не только фон, но также и пороговое значение обновляются для каждого пиксе-

ля в отдельности. Кроме того, фон обновляется для всех типов пикселей: как для

переднеплановых, так и для фоновых. Это приводит к тому, что данная модифи-

кация метода вычитания фона позволяет учитывать повторяющиеся изменения

внешних условий, а также избегать сегментации движущихся объектов, появля-

ющихся на изображении, как фоновых.

Для корректной работы представленного метода необходимо аккуратно вы-

бирать значение р. Если оно будет слишком мало, то объекты переднего плана

будут быстро классифицироваться как фоновые, что приведет к неправильной

сегментации в последующих кадрах. Кроме того, будет невозможным детекти-

рование остановившихся объектов. Если же выбрать значение Д слишком боль-

шим, переднеплановые объекты никогда не будут переходить в фоновые, не по-

зволяя отражать долговременные изменения сцены.

Указанные соображения приобретают особенно большое значение в та-

ких сферах применения систем видеонаблюдсния, как мониторинг транспорт-

ных средств на автомобильных парковках. Там постоянно встречается ситуация,

когда автомобиль, долгое время стоявший на парковочном месте, выезжает со

стоянки. При этом фоновое изображение обязательно должно быть обновлено.

Обратный процесс - остановка автомобилей в поле зрения камеры. Через неко-

торое время такой автомобиль должен быть отнесен к фоновому изображению.

Данная операция называется интеграцией объекта. Существенным недостатком

всех рассмотренных выше алгоритмов является то, что время интеграции чрез-

вычайно сложно контролировать. Во-первых, оно зависит от окраски объекта.

Действительно, если объект многоцветный, то некоторые области интегрируют-

ся в фон быстрее других. Во-вторых, если объект двигается медленно или оста-

навливается на короткое время, то в фоновое изображение могут быть внесены

ошибочные возмущения.

Для учета этих соображений иногда вводятся специальные индикаторы, по-

зволяющие контролировать процесс интеграции объектов. Основная идея за-

ключается в обновлении пикселей только в том случае, если достигнута так на-

зываемая «стабильность наблюдений», т.е. за определенный промежуток вре-

мени не зафиксировано никаких изменений в данной области изображения. Для

того чтобы алгоритм был рекурсивным, индикаторы стабильности учитывают

историю изменений каждого пикселя. Как только будет зафиксировано движе-

http://www.itv.ru

Компания ITV - генеральный спонсор издания книги

30

Цифвая обработка видеоизображений

ние в области, к которой принадлежит рассматриваемый пиксель, индикатор

стабильности для него принимает минимальное (нулевое) значение. Если в сле-

дующих кадрах изменений не наблюдается, индикатор постепенно увеличива-

ется, пока не достигнет своего максимального значения, равного 1. Шаг измене-

ния индикатора 0 определяется величиной, называемой задержкой интеграции,

и зависит от контекста анализируемой информации. Обновление фона проис-

ходит только тогда, когда индикатор стабильности становится равным 1. Это

позволяет не обновлять те части фонового изображения, которые были недав-

но обновлены, и где теперь снова зафиксировано движение. Остановившийся

объект автоматически сегментируется в фон через промежуток времени, рав-

ный задержке интеграции.

При выполнении условия

(17)

индикатор стабильности 5 определяется из следующего соотношения:

(18)

Для учета медленных изменений, происходящих в анализируемой сцене, в мо-

дели вычитания фона можно использовать простые статистические соображе-

ния. Например, для каждого пикселя в текущем кадре t вычисляются скользящее

среднее It и стандартное отклонение которые затем обновляются с помощью

следующих формул:

4+1 = a/Itl+(l-a)/„

(19)

^i = a[7M-A,i]+(l-a)q, (20)

где а = т /, /- количество кадров в секунду, а постоянная величина т определя-

ет, насколько быстро должен изменяться фон при изменении внешних условий.

Влияние старых изменений уменьшается со временем по экспоненциальному за-

кону, тем самым, позволяя фону отражать текущее состояние внешних условий.

Если значение пикселя / (х, у) отличается от 7t более чем на 2ar, то такой

пиксель считается переднеплановым. Для него инициализируется новый на-

бор статистических параметров а исходный набор временно сохраня-

ется. Если по прошествии времени Т = Зт значение пикселя не вернулось к ста-

рым статистическим параметрам, то новые статистики окончательно заменяют

старые.

В качестве статистических характеристик отдельных пикселей могут так-

же выступать следующие величины: минимальное (/mm) и максимальное (Zmax)

значения интенсивности, а также максимум разницы интенсивности (Д) по-

следовательных кадров. Все указанные величины рассчитываются в началь-

ный период наблюдения, когда сцена не содержит движущихся объектов.

Тогда пиксель (х, у) в текущем кадре / считается переднеплановым, если вы-

полнено хотя бы одно из условий:

ProSystem CCTV - журнал по системам видеонаблюдения

http://www.procctv.ru

Глава 2. Построение моделей фона и выделение переднего плана

31

knuo(x.y)-A(x.y)|>AUA <21)

|/пИ»(^>’)-/1(х.>')|>д(х’>’). (22)

Как уже упоминалось, большое значение при анализе видеоизображений

имеет корректный учет шумовой составляющей сигнала. Одним из возможных

решений, отвечающих указанному требованию, является использование филь-

тра Кальмана. Пусть процесс изменения значений фоновых пикселей описывает-

ся системой для обработки цифровых сигналов, состояние которой в момент вре-

мени г с учетом шума может быть оценено с помощью следующего фильтра:

7(х,у,/) = 7(х,у,г) + Л:(х)у,/)[/(х,.у./)-//(г)/(х,7,/)], (23)

l(x,y,t) = A(t) (24)

Здесь I(x, у, t) - оценка интенсивности пикселя (х, у) в момент времени Z,

A(t) - системная матрица, H(t) - матрица измерений. К(ху у, t) - матрица усиления

Кальмана, получающаяся из ковариационной матрицы ошибки предсказания со-

стояния системы (усиление велико для небольшого шума и наоборот). При по-

мощи уравнений (23) и (24) предсказывается новое состояние системы, затем оно

сравнивается с действительным значением и получается новая оценка путем ком-

бинации измеренного и предсказанного значений с весовыми коэффициентами.

Поэтому те измеренные значения, которые не соответствуют реальному поведе-

нию системы, входят в уравнения с меньшим весом. Данный алгоритм является

рекурсивным, т. е. оценка состояния системы включает в себя всю предыдущую

информацию, при этом не храня все измеренные значения.

Помимо оценки значения интенсивности пикселя 1(х, у, t), можно также

использовать оценку /(х, у, t) изменения интенсивности между двумя после-

довательными кадрами. В этом случае уравнения (23) и (24) примут следую-

щий вид:

Переменным а12 и рекомендуется присвоить значения порядка 0.7. Для полуто-

новых изображений матрица Н может быть выбрана постоянной:

Н = [1 0], (28)

а переменные для усиления заданы в следующей форме:

http://www.itv.ru

Компания ITV - генеральный спонсор издания книги

32

Цифвая обработка видеоизображений

K{x,y,t)

(29)

где

к\ (*> У>0 = ^2 (х»У*t)= а 'М (х,У,t -1) + Р[1 - М (х,у,t -1)]. (30)

Значения М(х, у, I) представляют собой маску сегментации изображения в перед-

ний план (М=1) или в фон (Л/=0):

M(x,y,t) =

1,

0,

£>(х,у,г-1)> 5

D(x, у,/-1)< 5

(31)

D(х,у,t) -1/ (х, у,г) -I (х, у,/)|. (32)

Значение 8 следует выбирать таким образом, чтобы небольшие отличия в интен-

сивностях пикселей приводили к быстрому изменению фона, а значительная раз-

ница интенсивностей сегментировалась в передний план.

Хотя такой алгоритм и используется для выделения переднего плана и тре-

кинга объектов, однако в рассмотренном виде он накладывает слишком боль-

шие ограничения на свойства входной видеопоследовательности.Так, например, из

уравнений (30)-(32) следует, что усиление К в кадре t зависит от сегментации в мо-

мент времени /-1. Это означает, что пиксель в момент /, ставший в действительно-

сти частью переднего плана, адаптируется туда на первом же шаге фильтрации

с использованием большего, отвечающего за изменение фона коэффициента Д,

вместо того чтобы задействовать меньший по величине и соответствующий адап-

тации переднего плана коэффициент а. Если мы хотим отразить изменения осве-

щенности в фоновой модели, при этом невозможно избежать изменений переднего

плана. А это нежелательно по той причине, что медленно движущиеся и периоди-

чески останавливающиеся объекты закрывают пиксели фона на более продолжи-

тельное время по сравнению с быстро движущимися объектами. Если объект пре-

кратил свое движение, то через несколько итераций он будет сегментирован в фон.

Начав через некоторое время свое движение вновь, он будет детектирован дваж-

ды: в своем нынешнем положении и в том, где он останавливался.

Для устранения указанных недостатков метод может быть модифицирован

путем замены уравнения (30) на следующее:

kt(x,y,t) = k2(x,y,t) =

а,

Р.

(d'(x,y,t) > 5)и[(</'(х«^’0<5)П(^"(х>л0* 5)] 33)

(d'(x,y,t)< 5)

где

d'(x,y,t) = \l(x,y,t)-I(x,y,t)[

d"(x,y,t) = |/ (x,y,t)~ 7'(х,7>4

i'(x,y,t) = l (x,y,t)+ /3-[1 (х,у,/)-7(х,у,/)],

(34)

(35)

(36)

ProSystem CCTV - журнал по системам видеонаблюдения

http://wwwprocctv.ru

“лава 2. Построение моделей фона и выделение переднего плана

33

Таким образом, если разность (Г превышает пороговое значение, то этот пиксель

принадлежит к переднему плану и оценка значения пикселя производится с ис-