Текст

ТЕКСТОВАЯ МАГИЯ: КАК НЕЙРОСЕТИ

ТРАНСФОРМИРУЮТ ОБРАБОТКУ ЕСТЕСТВЕННОГО

ЯЗЫКА

ДЖЕИД КАРТЕР

W

гл

гп

X

О

сл

Q1

ГП

Джейд Картер

Нейросети. Обработка

естественного языка

«Автор»

2023

Картер Д.

Нейросети. Обработка естественного языка / Д. Картер —

«Автор», 2023

Книга представляет собой исчерпывающее руководство по применению

нейросетей в различных областях анализа текста. С этой книгой читатели

отправятся в увлекательное путешествие по миру искусственного интеллекта,

где они узнают о бесконечных возможностях, которые предоставляют

нейронные сети.

© Картер Д., 2023

© Автор, 2023

Д. Картер. «Нейросети. Обработка естественного языка»

Содержание

Введение 5

Глава 1: Введение в обработку естественного языка и нейросети 6

Глава 2: Основы нейронных сетей для NLP 13

Глава 3: Машинный перевод 69

Глава 4: Сентимент-анализ 87

Глава 5: Генерация текста 102

Глава 6: Вопросно-ответные системы 115

Глава 7: Этические и социальные аспекты NLP и нейросетей 129

Глава 8: Будущее NLP и нейросетей 140

Глава 9: Практические примеры и учебные задания 148

4

Д. Картер. «Нейросети. Обработка естественного языка»

Джейд Картер

Нейросети. Обработка естественного языка

Введение

В мире, где информация преображается в валовый объем текстов, обработка естествен-

ного языка (NLP) стала неотъемлемой частью нашего повседневного взаимодействия. От пере-

писки в социальных сетях до поиска информации в сети, от автоматизированных ассистентов

до перевода на другие языки, обработка текста стала не просто инструментом, а неотъемлемой

частью современной культуры и бизнеса.

Все это стало возможным благодаря нейросетям - мощному инструменту искусственного

интеллекта, способному анализировать, понимать и генерировать текст с удивительной точно-

стью. Нейронные сети обрели огромное значение для обработки естественного языка, взлетев

на вершину развития в этой области.

Эта книга - не просто техническое руководство, но и увлекательное путешествие в мир

текста, смысла и их интерпретации с помощью нейронных сетей.

Мы погрузимся в архитектуры нейросетей, их сложности и возможности. Мы разбе-

ремся, как слова превращаются в вектора, как алгоритмы способны понимать тональность тек-

ста и даже создавать свой собственный контент. Мы рассмотрим задачи машинного перевода,

сентимент-анализа, генерации текста и вопросно-ответных систем - все с применением мощи

нейросетей.

Книга также обратит внимание на важные этические и социальные вопросы, связанные с

использованием нейросетей в анализе текста. Мы поговорим о справедливости, предвзятости

и том, как обеспечить, чтобы NLP приносила пользу всему обществу.

Вы окунетесь в мир текстов, алгоритмов и искусства обработки информации. Вас ждет

увлекательное путешествие от основ до передовых методов, от технических деталей до широ-

ких перспектив. Добро пожаловать в мир нейросетей и языка!

5

Д. Картер. «Нейросети. Обработка естественного языка»

Глава 1: Введение в обработку

естественного языка и нейросети

Определение обработки естественного языка (NLP) и её важность

Обработка естественного языка (NLP-Natural Language Processing) - это область искус-

ственного интеллекта, которая занимается разработкой методов и алгоритмов для анализа,

понимания, интерпретации и взаимодействия с естественным языком, на котором общается

человек. Эта область стремится дать компьютерам способность работать с текстами так же, как

это делают люди, с учетом контекста, смысла и тонких нюансов языка.

Важность NLP стала несомненной в современном мире, где текстовая информация

играет ключевую роль во многих аспектах жизни. Рассмотрим некоторые из аспектов, подчер-

кивающие важность обработки естественного языка:

1. Коммуникация с компьютерами:

Обработка естественного языка (NLP) играет революционную роль в том, как люди вза-

имодействуют с компьютерами и технологией в целом. Интерфейсы взаимодействия между

человеком и компьютером часто требовали технической экспертизы или знаний, чтобы эффек-

тивно использовать их. Однако NLP меняет этот подход, предоставляя интуитивный и есте-

ственный способ взаимодействия.

До появления NLP, пользователи обычно должны были обучаться специальным коман-

дам, синтаксису и интерфейсам, чтобы взаимодействовать с программами и системами. Это

создавало барьер для вовлечения не-технических пользователей и замедляло внедрение тех-

нологий в разные сферы жизни.

NLP позволяет преодолеть этот барьер, предоставляя возможность вводить команды и

запросы на естественном языке, таком, как мы общаемся на повседневном уровне. Это озна-

чает, что даже те, кто не обладает техническими навыками, могут легко использовать компью-

теры, телефоны, устройства умного дома и другие технологии.

Примеры использования включают:

- Виртуальные ассистенты: Сегодняшние виртуальные ассистенты, такие как Siri, Google

Assistant и Amazon Alexa, позволяют пользователям задавать вопросы, давать команды и полу-

чать информацию с помощью своего естественного голоса. Это значительно упрощает взаимо-

действие с устройствами и выполняемыми ими задачами.

- Поиск и навигация: Системы NLP позволяют пользователям задавать поисковые

запросы в свободной форме, и компьютеры могут интерпретировать их смысл и предоставлять

соответствующие результаты. Это делает процесс поиска информации более естественным и

удобным.

- Команды умного дома: Устройства умного дома, такие как умные колонки и термо-

статы, позволяют пользователям управлять своим окружением с помощью голосовых команд.

Это делает домашнюю автоматизацию более доступной.

Кратко говоря, NLP делает технологии более интуитивными и доступными, позволяя

людям взаимодействовать с компьютерами так, как они общаются друг с другом. Это устра-

няет барьеры в использовании технологий и делает их доступными для широкой аудитории,

способствуя повсеместному внедрению инноваций.

2. Интернет и поиск информации:

Большая часть информации в современном мире находится в текстовом формате и пред-

ставлена в сети Интернет. Это может быть новостной контент, статьи, блоги, обзоры, описания

товаров, комментарии и многое другое. Однако доступ к этой огромной информационной базе

6

Д. Картер. «Нейросети. Обработка естественного языка»

не всегда простой задачей. И вот здесь вступает в игру обработка естественного языка (NLP),

делая доступ к знаниям и информации более эффективным и удобным.

Подходы NLP изменяют способ, которым мы можем искать, фильтровать и агрегировать

информацию в Интернете:

- Более точные поисковые системы. Традиционные поисковые системы, хотя и предостав-

ляют результаты, все же могут быть не всегда точными. С помощью NLP поисковые запросы

становятся более контекстуальными и понятными для машин, что позволяет предоставлять

более релевантные и точные результаты.

- Поиск семантически связанных данных. NLP способствует пониманию связей между

словами и концепциями. Это позволяет системам более точно понимать запросы пользователя

и находить материалы, связанные не только по ключевым словам, но и по контексту и смыслу.

- Агрегаторы новостей и обзоров. NLP может считывать и обрабатывать огромное коли-

чество новостей и статей, выделяя ключевую информацию и предоставляя сводки или краткие

обзоры. Это позволяет людям быстро ознакомиться с событиями и трендами, даже если вре-

мени на чтение длинных текстов ограничено.

- Поиск в больших объемах текстов. В корпоративной среде, аналитика и поиск инфор-

мации могут быть критически важными задачами. NLP позволяет автоматически обрабаты-

вать и анализировать большие объемы текстов, что упрощает нахождение необходимой инфор-

мации.

- Анализ мнений и отзывов. Большое количество отзывов и комментариев находится в

текстовом формате. NLP помогает автоматически анализировать этот контент, выделяя сен-

тимент, тенденции и важные моменты, что может быть полезно для бизнеса и маркетинга.

NLP играет ключевую роль в улучшении способов доступа к информации в интернете.

Это делает процесс поиска и агрегации информации более удобным, эффективным и интел-

лектуально обогащенным, что в итоге повышает качество взаимодействия человека с инфор-

мационными ресурсами.

3. Машинный перевод:

В современном мире, где международные связи становятся все более плотными, свобод-

ный обмен информацией между разными культурами и на разных языках становится ключевой

задачей. Однако различия в языках могут создавать языковой барьер, затрудняя понимание и

коммуникацию между людьми разных национальностей.

В этом контексте обработка естественного языка (NLP) выходит на передний план как

технология, способствующая разрыву этого барьера и стимулирующая межкультурный обмен.

Автоматические системы машинного перевода, разрабатываемые с использованием NLP, спо-

собны переводить тексты с одного языка на другой, сохраняя смысл и контекст. Продвижения

в области машинного перевода, такие как технология трансформеров, позволяют создавать

более точные и естественные переводы, уменьшая языковой барьер между людьми.

Кроме того, компании и разработчики могут использовать NLP для адаптации своего

контента и продуктов к разным языкам и культурам. Это важно не только для внешней ком-

муникации, но и для предоставления качественного опыта пользователя в разных частях мира.

Развитие технологий NLP и компьютерного зрения позволяет создавать мультимодаль-

ные переводчики, которые способны переводить не только текст, но и изображения, звуковые

сигналы и видео. Это улучшает возможности взаимодействия между людьми, говорящими на

разных языках.

Наконец, NLP играет важную роль в образовательных проектах и культурном обмене.

Платформы для онлайн-курсов и образовательных ресурсов могут использовать машинный

перевод для расширения своей аудитории и достижения учащихся из разных стран.

В итоге, благодаря технологиям NLP и автоматическим системам машинного перевода,

языковой барьер уменьшается, что способствует свободному обмену идеями, культурой, зна-

7

Д. Картер. «Нейросети. Обработка естественного языка»

нием и информацией между разными культурами. Это поднимает культурный обмен на новый

уровень, делая его более доступным, интересным и важным для общества в целом.

4. Анализ тональности и настроений:

Понимание тональности текста - это существенный аспект для различных сфер деятель-

ности, таких как бизнес, социальные медиа и маркетинг. Нейронные сети и методы обработки

естественного языка (NLP) играют важную роль в этом процессе, позволяя автоматически ана-

лизировать отзывы, комментарии и обсуждения, что в свою очередь помогает оценивать обще-

ственное мнение и восприятие.

Бизнес и маркетинг используют анализ тональности текстов для оценки реакции клиен-

тов на продукты и услуги. Автоматическая обработка большого объема отзывов и коммента-

риев позволяет компаниям более точно понимать, как их продукты оцениваются клиентами.

Это может помочь в улучшении качества продукции, а также в адаптации маркетинговых стра-

тегий.

Социальные медиа являются ещё одной областью, где анализ тональности текста имеет

большое значение. Бренды, знаменитости и обычные пользователи активно общаются в соци-

альных сетях, оставляя комментарии, рецензии и отзывы. Автоматический анализ помогает

определить, как публика реагирует на конкретные события, новости или продукты, что позво-

ляет принимать более информированные решения.

Более того, анализ тональности текста может быть использован для мониторинга обще-

ственного мнения и предсказания трендов. Это может быть полезно для прогнозирования

изменений на рынке, выявления возможных кризисов и понимания общественных настроений.

Суммируя, NLP открывает перед бизнесом, социальными медиа и маркетингом новые

возможности для более глубокого и точного анализа текстов и определения их тонально-

сти. Это позволяет более эффективно взаимодействовать с аудиторией, улучшать продукты и

услуги, а также более четко выстраивать стратегии на основе общественных реакций.

5. Генерация контента:

Обработка естественного языка (NLP) стала неотъемлемой частью современных техно-

логий, позволяя автоматизировать и упростить создание текстового контента во многих обла-

стях. Этот аспект особенно интересен в сферах, где требуется большой объем текста, начиная

от новостных публикаций и заканчивая креативными проектами.

Автоматическая генерация новостей и статей.

С помощью NLP возможно создание текстовых статей и новостных сообщений без необ-

ходимости полного участия человека. Нейронные сети могут анализировать большие объемы

данных, извлекать ключевые факты и события, а затем формировать их в структурированный

и читаемый текст. Это может быть полезно, например, для автоматического генерирования

финансовых отчетов, спортивных новостей или погодных прогнозов.

Создание контента для маркетинга.

NLP позволяет создавать тексты для маркетинговых материалов, таких как рекламные

слоганы, описания продуктов, блог-посты и рассылки. С помощью алгоритмов NLP можно

создавать контент, который затрагивает интересы целевой аудитории, делая маркетинг более

персонализированным и эффективным.

Креативные проекты и искусство.

NLP может быть использовано для создания художественных текстов, стихотворений,

историй и даже музыкальных текстов. Нейросети могут анализировать структуры и стили раз-

личных авторов, а затем генерировать тексты в подобных стилях. Это открывает двери для

новых форм искусства и экспериментов с креативными идеями.

Создание контента для социальных медиа.

8

Д. Картер. «Нейросети. Обработка естественного языка»

Автоматически сгенерированный контент может быть использован для заполнения соци-

альных медиа-профилей компаний, публикации регулярных обновлений или даже создания

мемов и смешных картинок с подписями.

Важно отметить, что хотя NLP дает возможность автоматически создавать текстовый

контент, человеческое вмешательство и контроль могут оставаться необходимыми. Помимо

творческих проектов, алгоритмы NLP могут использоваться для предварительной генерации

текстов, которые затем могут быть доработаны и отредактированы специалистами в соответ-

ствии с конкретными целями и стандартами.

6. Медицинская диагностика и исследования:

Обработка естественного языка (NLP) играет существенную роль в области здравоохра-

нения, где большие объемы медицинских текстов требуют детального анализа и интерпрета-

ции. Эта технология применяется для обработки медицинских записей, статей, клинических

исследований и других текстовых данных, что влияет на улучшение диагностики и научных

исследований в медицине.

Автоматическая обработка медицинских текстов с помощью NLP позволяет:

- Извлекать информацию из медицинских записей: Медицинские данные, такие как исто-

рии болезни, результаты тестов и отчеты о лечении, часто представлены в текстовой форме.

NLP позволяет автоматически извлекать важные медицинские факты и события из этих запи-

сей, что помогает врачам и исследователям быстрее обнаруживать паттерны и изменения в

здоровье пациентов.

- Поддерживать клинические исследования: В больших масштабах клинических иссле-

дований сбор и анализ данных может быть огромной задачей. NLP может помочь автомати-

зировать процессы обработки текстовых данных, ускоряя анализ и выявление статистически

значимых результатов.

- Улучшать точность диагностики: NLP способствует анализу большого объема меди-

цинских публикаций и исследований, что позволяет врачам получать обновленную информа-

цию о симптомах, лечении и прогнозах различных заболеваний. Это может повысить качество

диагностики и выбора оптимальных методов лечения.

- Мониторинг здоровья пациентов: NLP может быть использовано для анализа тексто-

вых данных, собранных от пациентов через вопросники или онлайн-журналы здоровья. Это

позволяет врачам исследовать долгосрочные тенденции в здоровье и реагировать на них.

- Оптимизировать медицинскую документацию: В больницах и клиниках меди-

цинская документация может быть объемной и сложной. NLP может использо-

ваться для автоматической категоризации и аннотации медицинских записей, что улуч-

9

Д. Картер. «Нейросети. Обработка естественного языка»

организацию и доступ к данным.

7. Именованные сущности (NER):

Задача извлечения именованных сущностей (NER) в обработке естественного языка

(NLP) является фундаментальной и важной частью многих приложений, связанных с анализом

текстовых данных. В этой задаче нейронные сети выявляют и классифицируют именованные

сущности в тексте, что позволяет извлекать структурированную информацию из неструктури-

рованных текстов. Вот более подробное объяснение этой задачи:

Что такое именованные сущности (NER)?

Именованные сущности - это конкретные слова или фразы в тексте, которые представ-

ляют собой уникальные имена или метки. Эти имена могут включать в себя:

- Имена людей: Например, "Джон Смит".

- Названия организаций: Например, "Google" или "Международный Красный Крест".

-Местоположения: Например, "Париж" или "Миссисипи".

10

Д. Картер. «Нейросети. Обработка естественного языка»

- Даты: Например, "10 марта 1990 года".

- Валюты: Например, "$100" или "1,000 евро".

- Проценты: Например, "20%" или "50 процентов".

- Ключевые события: Например, "Вторая мировая война".

- Продукты и бренды: Например, "iPhone" или "Coca-Cola".

Извлечение именованных сущностей имеет большое значение для разных задач NLP и

информационного поиска:

Структурированная информация: Позволяет преобразовать неструктурированный текст

в структурированные данные, что облегчает поиск и анализ информации.

Информационный поиск: Улучшает качество поисковых систем, позволяя точнее нахо-

дить источники или документы, содержащие конкретные именованные сущности.

Анализ социальных медиа: Помогает в анализе обсуждений организаций, событий и пер-

сон в социальных сетях.

Автоматическое создание баз данных: Позволяет автоматически заполнять базы данных

или справочники данными из текстовых источников.

Именованные сущности - это ключевой элемент для понимания и анализа текстовых

данных, и их извлечение с помощью нейросетей существенно улучшает возможности автома-

тической обработки текста в различных областях, включая информационный поиск, анализ

социальных медиа и автоматическое создание баз данных.

8. Автоматическая суммаризация:

Автоматическая суммаризация - это задача, в которой нейросети могут создавать крат-

кие и информативные резюме больших текстовых документов. Этот процесс позволяет выде-

лить наиболее важные и значимые аспекты текста, удалив при этом избыточную или менее

важную информацию. Автоматическая суммаризация имеет ряд важных применений:

1. Обзоры новостей: Новостные агентства и интернет-платформы могут использовать

автоматическую суммаризацию, чтобы предоставлять читателям краткие обзоры главных

событий и новостей из различных источников.

2. Анализ научных статей: Исследователи и ученые могут использовать автоматическую

суммаризацию для быстрого изучения содержания научных статей и исследований, что помо-

гает в научной работе и литературном обзоре.

3. Извлечение ключевых моментов из текста: Автоматическая суммаризация может быть

полезной для выявления ключевых фактов, событий или информации из текста, что упрощает

принятие решений и анализ текстовых данных.

Использование нейросетей для автоматической суммаризации позволяет создавать более

точные и информативные краткие версии текста, что может быть очень полезно в областях, где

требуется обработка и анализ больших объемов текстовой информации.

9. Чат-боты:

Чат-боты - это компьютерные программы, которые разработаны для автоматического

взаимодействия с пользователями на естественном языке. Они могут выполнять разнообраз-

ные задачи, от ответов на часто задаваемые вопросы до выполнения более сложных функций,

таких как заказ продуктов или бронирование билетов. Нейронные сети играют ключевую роль

в разработке и функционировании чат-ботов. Рассмотрим подробнее об их применении:

1. Архитектуры нейронных сетей в чат-ботах**:

- Рекуррентные нейронные сети (RNN): RNN часто используются в чат-ботах для обра-

ботки последовательности вопросов и ответов. Они могут хранить контекст предыдущих

вопросов и использовать этот контекст для формирования более информативных ответов.

- Сверточные нейронные сети (CNN): CNN могут использоваться для обработки текста,

выявления ключевых фраз и выделения важных элементов в тексте.

11

Д. Картер. «Нейросети. Обработка естественного языка»

- Трансформеры, такие как BERT или GPT, стали популярными в чат-ботах благодаря

своей способности учитывать контекст и генерировать более человекоподобные ответы.

2. Обучение нейронных сетей для чат-ботов:

- Обучение с учителем: В некоторых случаях чат-боты могут быть обучены на большом

корпусе чатов с людьми, чтобы научиться отвечать на типичные вопросы и запросы. Этот метод

требует большого объема данных и времени на обучение.

- Обучение с подкреплением: В других случаях чат-боты могут использовать метод обу-

чения с подкреплением, где они получают обратную связь от пользователей и настраивают свои

ответы на основе успешных взаимодействий.

3. Применение чат-ботов

- Обслуживание клиентов: Чат-боты часто используются компаниями для предоставле-

ния быстрого и эффективного обслуживания клиентов, отвечая на вопросы, уточняя инфор-

мацию о продуктах и услугах, а также решая проблемы клиентов.

- Онлайн-торговля: Чат-боты могут помочь пользователям выбрать продукты, советовать

товары и даже обрабатывать заказы и платежи.

- Образование и консультирование: В образовании и консультационных услугах чат-боты

могут предоставлять информацию, решать задачи и помогать в обучении.

- Развлечения и развлекательные приложения: Чат-боты используются в играх и раз-

влекательных приложениях для взаимодействия с пользователем и создания интересного кон-

тента.

- Системы управления: Чат-боты также используются для управления умными домами,

заказа такси, бронирования билетов и других задач автоматизации.

Чат-боты, поддерживаемые нейронными сетями, стали важной частью многих сфер биз-

неса и обслуживания клиентов. Они позволяют компаниям автоматизировать часть обслужи-

вания и улучшить взаимодействие с пользователями, обеспечивая более быстрый и эффектив-

ный способ получения информации и решения задач.

Таким образом, NLP играет важную роль в улучшении диагностики, исследований и

общей эффективности здравоохранения, помогая обрабатывать и анализировать огромные

объемы медицинских текстовых данных.

В этой книге мы будем исследовать, как нейронные сети, являющиеся одной из самых

мощных и актуальных технологий искусственного интеллекта, применяются для решения

задач обработки естественного языка. Наше путешествие начнется с основ, и мы увидим, как

эти нейросети способны преобразовать текст в понимание, анализ и даже творчество.

12

Д. Картер. «Нейросети. Обработка естественного языка»

Глава 2: Основы нейронных сетей для NLP

2.1. Обзор архитектур нейросетей, применяемых в

NLP, включая рекуррентные и сверточные модели

Обработка естественного языка (NLP) представляет собой широкую область, где ней-

ронные сети добились значительных успехов. В NLP используются разнообразные архитек-

туры нейросетей, которые позволяют обрабатывать текстовую информацию. Давайте рассмот-

рим две основные архитектуры: рекуррентные нейронные сети (RNN) и сверточные нейронные

сети (CNN).

Рекуррентные нейронные сети (RNN)

RNN представляют собой мощный класс архитектур, разработанный для обработки

последовательных данных, таких как текст, временные ряды и аудиосигналы. Основная осо-

бенность RNN заключается в том, что они обладают обратными связями, которые позволяют

информации из предыдущих шагов влиять на текущие вычисления. Это делает RNN особенно

подходящими для задач, где важен контекст и зависимость между данными в разных частях

последовательности.

Основные компоненты RNN включают в себя:

1. Скрытое состояние (Hidden State): Скрытое состояние является одной из ключе-

вых концепций в рекуррентных нейронных сетях (RNN). Оно представляет собой внутреннее

состояние сети, которое аккумулирует информацию о предыдущих элементах в последователь-

ности. Давайте подробнее рассмотрим этот концепт:

- Основное предназначение:

Скрытое состояние в RNN служит для сохранения и передачи информации о контексте

последовательности данных. Каждый элемент (например, слово в тексте) последовательности

влияет на состояние сети, и это состояние обновляется с каждым новым элементом. Таким

образом, скрытое состояние может содержать информацию о том, что произошло в прошлом,

и влиять на то, как будет обработан следующий элемент.

- Функция скрытого состояния:

Скрытое состояние RNN можно представить как вектор, который хранит информацию,

актуальную на текущем этапе обработки последовательности. Этот вектор может включать в

себя разнообразную информацию, в зависимости от конкретной задачи:

*История: Скрытое состояние может содержать информацию о предыдущих элементах

последовательности, что делает его способным сохранять контекст.

* Зависимости: Состояние может отражать зависимости и взаимосвязи между элемен-

тами последовательности, например, какие слова в тексте связаны между собой.

*Контекст: В зависимости от задачи, скрытое состояние может содержать контекстную

информацию, такую как смысл предложения или текста.

- Обновление скрытого состояния:

Обновление скрытого состояния происходит на каждом шаге обработки элемента после-

довательности. Это обновление определяется архитектурой сети и весами, которые подбира-

ются в процессе обучения.

- Использование скрытого состояния:

Скрытое состояние может использоваться в различных задачах. Например, в задаче

машинного перевода, скрытое состояние может содержать информацию о предыдущих словах

в исходном предложении и влиять на выбор следующего слова в переводе. В анализе тональ-

13

Д. Картер. «Нейросети. Обработка естественного языка»

ности текста, скрытое состояние может представлять собой агрегированную информацию о

предыдущих словах и помогать определить общий тон текста.

- Проблема затухания градиентов:

Важно отметить, что у классических RNN есть проблема затухания градиентов, которая

может привести к утере информации о более давних элементах последовательности. Это огра-

ничение привело к разработке более сложных архитектур RNN, таких как LSTM и GRU, кото-

рые способны эффективнее работать с долгосрочными зависимостями в данных.

Скрытое состояние в RNN играет важную роль в обработке последовательных данных и

позволяет сетям учитывать контекст и зависимости между элементами в последовательности.

Различные модификации RNN, такие как LSTM и GRU, были разработаны для устранения

ограничений и улучшения способности моделей к обработке более долгих и сложных после-

довательностей.

Для наглядного представления скрытого состояния в рекуррентных нейронных сетях

(RNN), давайте представим ситуацию, связанную с обработкой текстовых данных, чтобы

понять, как это работает.

Представьте, что у нас есть следующее предложение: "Сегодняшняя погода очень хоро-

шая." Мы хотим использовать RNN для анализа тональности этого предложения и определе-

ния, положительное оно или отрицательное.

1. Инициализация скрытого состояния:

На первом шаге обработки этого предложения скрытое состояние инициализируется

некоторым начальным значением, например, нулевым вектором. Это начальное состояние

несет в себе информацию о предыдущих шагах, но на этом этапе оно пустое.

2. Обработка слов поочередно:

Теперь мы начинаем обрабатывать слова в предложении поочередно, шаг за шагом. Для

каждого слова RNN обновляет свое скрытое состояние, учитывая информацию о предыдущих

словах и текущем слове. На этом этапе RNN может учитывать, что "Сегодняшняя" и "погода"

идут перед "очень" и "хорошая", и что они могут влиять на общий смысл предложения.

3. Агрегация информации:

После обработки всех слов в предложении скрытое состояние будет содержать инфор-

мацию, учитывающую контекст всего предложения. Это состояние может отражать, что весь

контекст в данном предложении указывает на положительную тональность.

4. Выдача результата:

Наконец, RNN может использовать это скрытое состояние для определения тональности

предложения, и, например, классифицировать его как "положительное".

Исходное состояние скрытого состояния (шаг 1) и его изменение по мере обработки каж-

дого слова (шаги 2 и 3) - это ключевые элементы работы RNN в обработке текстовых дан-

ных. Это позволяет модели учитывать зависимости между словами и контекст, что делает RNN

мощными инструментами в NLP.

Затем, чтобы понять, как работают более продвинутые архитектуры, такие как LSTM и

GRU, можно представить их как улучшенные версии RNN с более сложными механизмами

обновления скрытого состояния, которые позволяют им эффективнее учитывать долгосрочные

зависимости в данных.

Для реализации рекуррентной нейронной сети (RNN) в коде на Python с использованием

библиотеки глубокого обучения TensorFlow, можно следовать следующему шаблону. В данном

примере будет использован простой пример классификации текста с использованием RNN:

"python

import tensorflow as tf

from tensorflow.keras.layers import Embedding, SimpleRNN, Dense

from tensorflow.keras.models import Sequential

14

Д. Картер. «Нейросети. Обработка естественного языка»

from tensorflow.keras.preprocessing.text import Tokenizer

from tensorflow.keras.preprocessing.sequence import pad_sequences

# Пример текстовых данных для обучения

texts = ["Сегодняшняя погода очень хорошая.", "Дождь идет весь день.", "Ветер сильный,

но солнце светит."]

labels = [1, О, 1] # 1 - положительное, 0 - отрицательное

# Создание токенизатора и преобразование текста в последовательности чисел

tokenizer = Tokenizer()

tokenizer.fit_on_texts(texts)

sequences = tokenizer.texts_to_sequences(texts)

# Паддинг последовательностей для обеспечения одинаковой длины

max_sequence_length = max([len(seq) for seq in sequences])

sequences = pad_sequences(sequences, maxlen=max_sequence_length)

# Создание модели RNN

model = Sequential()

model.add(Embedding(input_dim=len(tokenizer.word_index) + 1, output_dim=64,

input_length=max_sequence_length))

model.add(SimpleRNN(32))

model.add(Dense(l, activation='sigmoid')) # Бинарная классификация

# Компиляция модели

model.compile(optimizer='adam', loss='binary_crossentropy', metrics=['accuracy'])

# Обучение модели

model.fit(sequences, labels, epochs=10, batch_size=l)

# Пример тестовых данных для предсказания

test_texts = ["Завтра будет солнечно.", "Дождь мне не нравится."]

test_sequences = tokenizer. texts_to_sequences(test_texts)

test_sequences = pad_sequences(test_sequences, maxlen=max_sequence_length)

# Предсказание классов

predictions = model.predict(test_sequences)

for i, text in enumerate(test_texts):

sentiment = "положительное" if predictions[i] > 0.5 else "отрицательное"

print(f"Текст: {text}, Прогноз тональности: {sentiment}")

Этот код демонстрирует базовую реализацию RNN для задачи анализа тональности тек-

ста. Важно отметить, что в реальных приложениях могут использоваться более сложные архи-

тектуры и данные.

2. Обратные связи (Feedback Loops):

Обратные связи (Feedback Loops) представляют собой ключевой механизм в рекуррент-

ных нейронных сетях (RNN) и других последовательных моделях машинного обучения. Эти

обратные связи обеспечивают возможность информации циркулировать между различными

моментами времени в последовательности данных, позволяя предыдущим шагам влиять на

текущие вычисления. Давайте более подробно разберемся, как это работает:

1. Последовательные данные:

Обратные связи особенно полезны при работе с последовательными данными, такими

как тексты, временные ряды или аудиосигналы, где значения зависят от предыдущих значений.

2. Скрытое состояние:

Основной механизм обратной связи в RNN заключается в использовании скрытого состо-

яния (Hidden State). На каждом временном шаге RNN обновляет свое скрытое состояние с

учетом текущего входа и предыдущего состояния.

15

Д. Картер. «Нейросети. Обработка естественного языка»

3. Информация о контексте:

Скрытое состояние сохраняет информацию о предыдущих элементах последовательно-

сти. Это позволяет модели учитывать контекст и зависимости между данными в разных частях

последовательности.

4. Пример работы:

Давайте представим следующую последовательность слов: "Я ел бутерброд. Затем я

выпил чашку кофе." В контексте обратных связей, RNN начнет с анализа слова "Я", и его скры-

тое состояние будет содержать информацию о нем. Когда сеть перейдет к слову "ел", скрытое

состояние будет учитывать и слово "Я", и слово "ел". Затем, когда сеть дойдет до "бутерброд",

скрытое состояние будет содержать информацию о всех трех предыдущих словах. Это позво-

ляет модели понимать, что "ел" - это глагол, относящийся к действию, начатому в предыдущем

предложении.

5. Затухание и взрыв градиентов:

Важно отметить, что обратные связи также могут быть источником проблем, таких как

затухание и взрыв градиентов. Если градиенты становятся слишком большими (взрыв градиен-

тов) или слишком маленькими (затухание градиентов), обучение RNN может стать затрудни-

тельным. Для решения этой проблемы были разработаны модификации RNN, такие как LSTM

и GRU, которые эффективнее управляют обратными связями и градиентами.

Обратные связи и скрытое состояние позволяют RNN учитывать контекст и зависимости

в последовательных данных, что делает их мощными инструментами в обработке текста, аудио

и других последовательных данных.

Для наглядности работы обратных связей (Feedback Loops) в рекуррентных нейронных

сетях (RNN), давайте представим упрощенную аналогию. Допустим, у нас есть "ум" с каран-

дашом, который пытается решить математическую задачу, но его способность решать задачи

основывается на информации, которую он имеет о предыдущих задачах. Это можно предста-

вить следующим образом:

Первая задача: Ум начинает решать математическую задачу: 2 + 2. Он записывает резуль-

тат, равный 4, на листе бумаги.

Обратная связь: Теперь, когда ум попытается решить следующую задачу, он видит

результат предыдущей задачи на своей записи. Это дает ему контекст и информацию для реше-

ния следующей задачи.

Вторая задача: 3 + 3. Ум видит, что в предыдущей задаче было 2 + 2 = 4. Это важная

информация, которая позволяет ему сделать вывод о том, как правильно решить новую задачу.

Он записывает результат 6 на бумаге.

Продолжение обратных связей: Процесс продолжается. Каждая задача дополняет записи

ума, и он использует информацию из предыдущих задач для решения новых задач.

Таким образом, информация из предыдущих задач (или моментов времени) влияет на

текущие вычисления и помогает уму (или нейронной сети) учитывать контекст и зависимо-

сти между задачами (или данными) в последовательности. Это аналогия к тому, как обратные

связи в RNN позволяют модели учитывать контекст и зависимости в последовательных дан-

ных, обновляя скрытое состояние на каждом временном шаге.

3. Параметры, обучаемые сетью:

Параметры, обучаемые сетью, играют критическую роль в работе рекуррентных ней-

ронных сетей (RNN). Эти параметры являются настраиваемыми переменными, которые сеть

использует для адаптации к конкретной задаче путем оптимизации их с использованием мето-

дов, таких как градиентный спуск. Вот подробное объяснение этого концепта:

1. Параметры сети:

16

Д. Картер. «Нейросети. Обработка естественного языка»

- Веса (Weights): Веса связей между нейронами внутри RNN. Эти веса определяют, как

информация передается от одного нейрона к другому и как она обновляется на каждом вре-

менном шаге.

- Смещения (Biases): Смещения добавляются к взвешенной сумме входов, перед приме-

нением активационной функции, и могут управлять смещением активации нейронов.

2. Инициализация параметров: Параметры RNN обычно инициализируются случайными

значениями перед началом обучения. Эти начальные значения могут быть заданы случайным

образом или с использованием различных методов инициализации весов.

3. Обучение сети: Во время обучения RNN параметры модели настраиваются для мини-

мизации функции потерь (loss function) на тренировочных данных. Это происходит с исполь-

зованием методов оптимизации, таких как градиентный спуск (gradient descent).

4. Градиентный спуск - это оптимизационный метод, который используется для обновле-

ния параметров сети на каждом этапе обучения. Он вычисляет градиент (производные) функ-

ции потерь по параметрам сети и обновляет параметры в направлении, которое минимизирует

функцию потерь.

5. Итерации обучения: Обучение RNN происходит итеративно на множестве трениро-

вочных данных. На каждой итерации параметры обновляются таким образом, чтобы умень-

шить ошибку модели на тренировочных данных.

6. Результат обучения: После завершения обучения параметры RNN настроены таким

образом, чтобы модель могла делать предсказания на новых данных, которые она ранее не

видела.

7. Тонкая настройка: Важно отметить, что оптимизация параметров RNN - это искус-

ство, и существует много методов для тонкой настройки параметров и параметров оптимиза-

ции, чтобы достичь лучшей производительности на конкретной задаче.

Параметры, обучаемые сетью, позволяют RNN адаптироваться к различным задачам и

данным, делая их мощным инструментом для разнообразных задач, связанных с последова-

тельными данными, включая обработку текста, анализ временных рядов и многое другое.

Давайте рассмотрим пример использования обучаемых параметров в нейронной сети на

языке Python с использованием библиотеки TensorFlow. В этом примере мы создадим простую

RNN для задачи прогнозирования временных рядов.

"python

import numpy as пр

import tensorflow as tf

from tensorflow.keras.models import Sequential

from tensorflow.keras.layers import SimpleRNN, Dense

# Генерируем пример временного ряда

np.random.seed(O)

n_steps = 100

time = np.linspace(O, 10, n_steps)

series = 0.1 * time + np.sin(time)

# Подготавливаем данные для обучения RNN

n_steps = 30 # количество временных шагов в одной последовательности

n_samples = len(series) - n_steps

X = [series[i:i+n_steps] for i in range(n_samples)]

у = series[n_steps:]

X = np.array(X).reshape(-l, n_steps, 1)

у = np.array(y)

# Создаем модель RNN

model = Sequential!)

17

Д. Картер. «Нейросети. Обработка естественного языка»

model.add(SimpleRNN(10, activation="relu", input_shape=[n_steps, 1]))

model.add(Dense( 1))

# Компилируем модель

model.compile(optimizer="adam", loss="mse")

# Обучаем модель

model.fit(X, у, epochs=10)

# Делаем прогноз на будущее

future_steps =10

future_x = X[-l,:]

future_predictions = []

for _ in range(future_steps):

future_pred = model.predict(future_x.reshape(l, n_steps, 1))

future_predictions. append(future_pred [0,0])

future_x = np.roll(future_x, shift=-1)

future_x[-l] = future_pred[O, 0]

# Выводим результаты

import matplotlib.pyplot as pit

plt.plot(np.arange(n_steps), X[-l,0], label="Исходные данные")

plt.plot(np.arange(n_steps, n_steps+future_steps), future_predictions, label="Прогноз")

р1Гх1аЬе1("Временной шаг")

pit .ylabel(" Значение")

plt.legend()

plt.show()

18

Д. Картер. «Нейросети. Обработка естественного языка»

Значение

1.0 -

0.5 -

0.0 -

т

т

т

Д. Картер. «Нейросети. Обработка естественного языка»

В этом примере:

- Мы создаем простую RNN с одним слоем, который прогнозирует следующее значение

временного ряда на основе предыдущих значений.

- Обучаем модель с использованием оптимизатора "adam" и функции потерь

"mse" (Mean Squared Error).

- Затем делаем прогнозы на несколько временных шагов вперед, обновляя входные дан-

ные с учетом предсказанных значений.

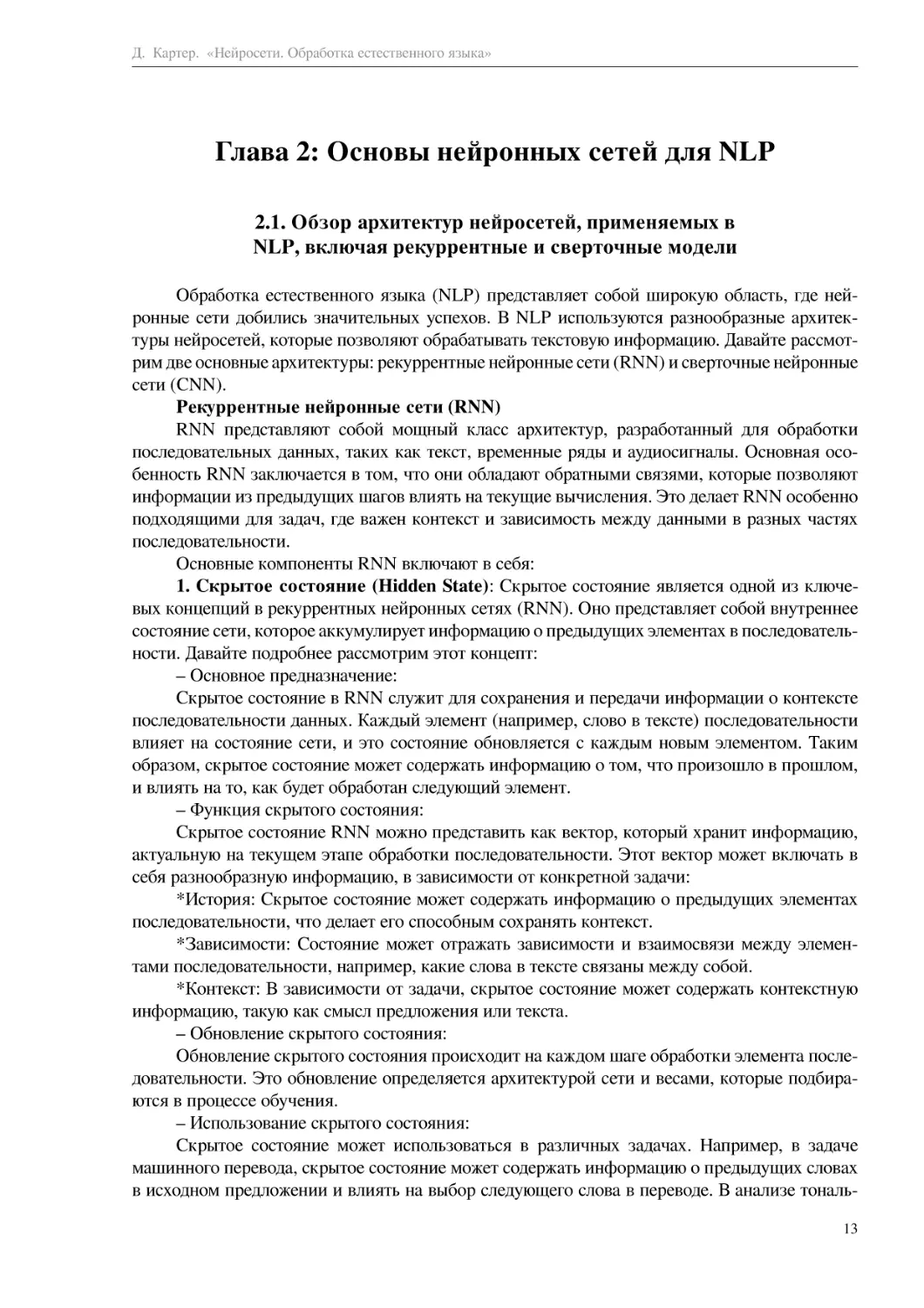

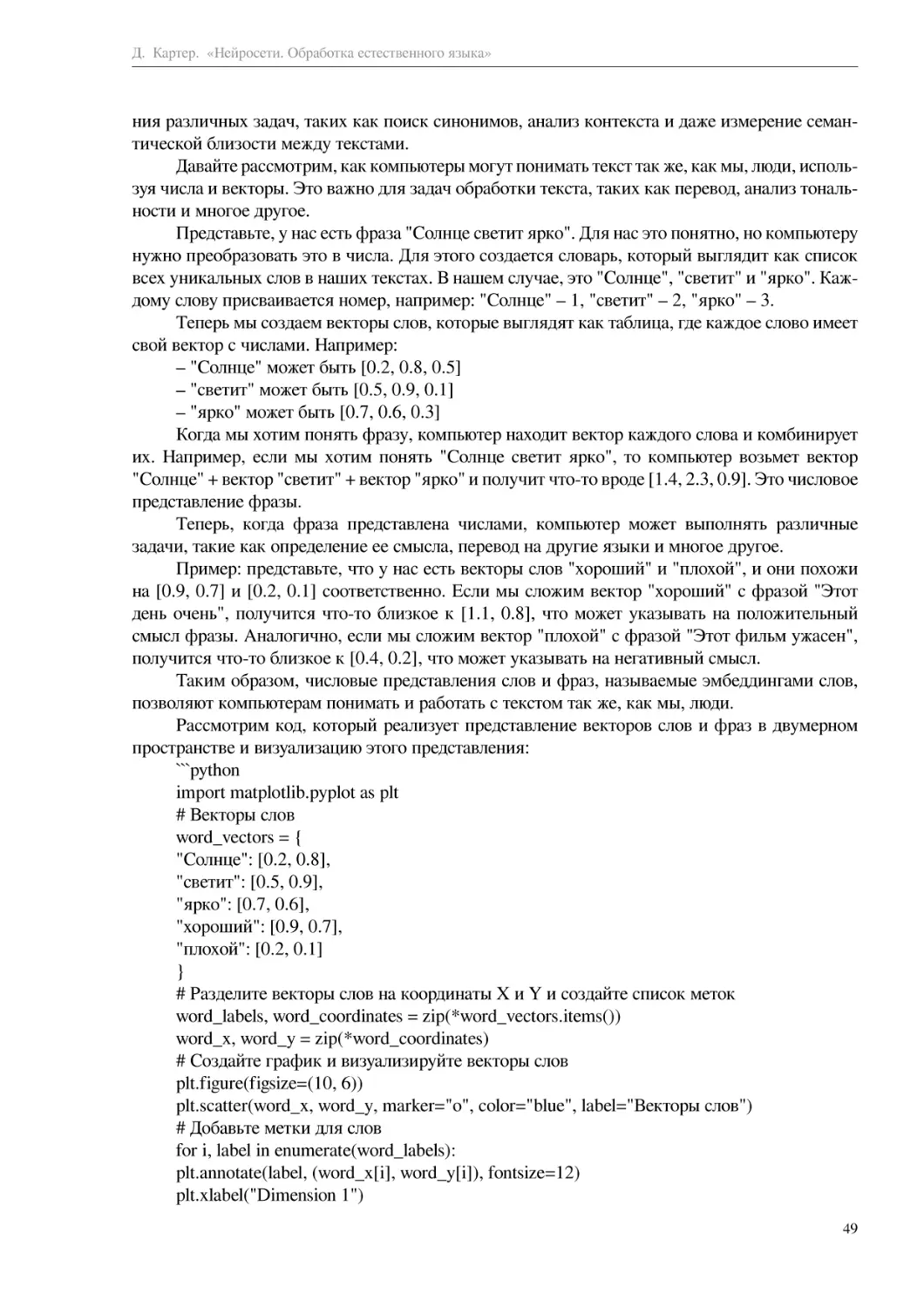

На результате кода, который вы предоставили, мы видим следующее:

1. Исходные данные (синяя линия): Это начальная часть временного ряда, который был

сгенерирован. В данном случае, это линейная функция (0.1 * time) с добавленными синусои-

дальными колебаниями (np.sin(time)).

2. Прогноз (оранжевая линия): Это результаты прогноза, сделанные моделью RNN на

будущее. Модель обучается на исходных данных и затем пытается предсказать значения вре-

менного ряда на заданное количество временных шагов вперед (future_steps).

Из этой визуализации видно, как модель RNN пытается аппроксимировать исходный вре-

менной ряд и делает прогнозы на основе предыдущих значений. Оранжевая линия отображает

прогнозируемую часть временного ряда на будущее.

Завершив обучение и сделав прогнозы, вы можете визуально оценить, насколько хорошо

модель справилась с задачей прогнозирования временного ряда.

В этом примере обучаемые параметры модели - это веса и смещения в слое RNN и в

слое Dense. Модель настраивает эти параметры в процессе обучения, чтобы минимизировать

ошибку прогноза временного ряда.

Обучаемые параметры позволяют модели адаптироваться к данным и находить законо-

мерности, что делает их мощным инструментом для разнообразных задач машинного обуче-

ния.

Однако RNN имеют несколько ограничений, из которых наиболее значимой является

проблема затухания градиентов (vanishing gradients). Эта проблема заключается в том, что

при обучении RNN градиенты (производные функции потерь по параметрам сети) могут ста-

новиться очень маленькими, особенно на длинных последовательностях. Это затрудняет обу-

чение, поскольку сеть может "забывать" информацию о давно прошедших событиях в после-

довательности.

Для решения проблемы затухания градиентов были разработаны более продвинутые

архитектуры RNN:

Long Short-Term Memory (LSTM):

Long Short-Term Memory (LSTM) - это одна из наиболее популярных архитектур в обла-

сти рекуррентных нейронных сетей (RNN). Она разработана для работы с последовательными

данными и способна эффективно учитывать долгосрочные зависимости в данных. Давайте

подробнее разберем, как работает LSTM:

Специальные ячейки LSTM: Основная особенность LSTM заключается в использовании

специальных ячеек памяти, которые позволяют сохранять и извлекать информацию из про-

шлых состояний. Эти ячейки состоят из нескольких внутренних гейтов (гейт - это устройство,

которое решает, какая информация должна быть сохранена и какая должна быть проигнори-

рована).

Забывающий гейт (Forget Gate): Этот гейт определяет, какая информация из прошлых

состояний следует забыть или удалить из памяти ячейки. Он работает с текущим входом и

предыдущим состоянием и выдает значение от 0 до 1 для каждой информации, которая ука-

зывает, следует ли ее забыть или сохранить.

20

Д. Картер. «Нейросети. Обработка естественного языка»

Входной гейт (Input Gate): Этот гейт определяет, какая информация из текущего входа

должна быть добавлена в память ячейки. Он также работает с текущим входом и предыдущим

состоянием, и вычисляет, какие значения следует обновить.

Обновление памяти (Cell State Update): На этом этапе обновляется состояние памяти

ячейки на основе результатов забывающего гейта и входного гейта. Это новое состояние

памяти будет использоваться на следующем временном шаге.

Выходной гейт (Output Gate): Этот гейт определяет, какую информацию из текущего

состояния памяти следует использовать на выходе. Он учитывает текущий вход и предыдущее

состояние, чтобы определить, какую информацию передать на выход.

Долгосрочные зависимости: Благодаря специальным ячейкам и гейтам, LSTM способна

учитывать долгосрочные зависимости в данных. Она может эффективно хранить информацию

на протяжении многих временных шагов и извлекать ее, когда это необходимо.

Применение LSTM: LSTM широко используется в задачах, связанных с последова-

тельными данными, таких как обработка текста, анализ временных рядов, машинный пере-

вод, генерация текста и многие другие. Ее способность учитывать долгосрочные зависимости

делает ее мощным инструментом для анализа и моделирования последовательных данных.

Лучший способ понять, как работает Long Short-Term Memory (LSTM), - это применить

его на практике в рамках конкретной задачи. Давайте рассмотрим пример применения LSTM

для анализа временных рядов в Python с использованием библиотеки TensorFlow и библиотеки

pandas:

"python

import numpy as np

import tensorflow as tf

import pandas as pd

import matplotlib.pyplot as pit

from tensorflow.keras.models import Sequential

from tensorflow.keras.layers import LSTM, Dense

# Генерируем пример временного ряда (синусоида)

timesteps = np.linspace(O, 100, 400)

series = np.sin(timesteps)

# Создаем датасет для обучения сети

df = pd.DataFrame({'timesteps': timesteps, 'series': series})

window_size = 10 # Размер окна для создания последовательных образцов

batch_size = 32 # Размер пакета

# Функция для создания последовательных образцов из временного ряда

def create_sequences(series, window_size, batch_size):

dataset = tf.data.Dataset.from_tensor_slices(series)

dataset = dataset.window(window_size + 1, shift=l, drop_remainder=True)

dataset = dataset.flat_map(lambda window: window.batch(window_size +1))

dataset = dataset.shuffle(1000).map(lambda window: (window[:-l], window[-l]))

dataset = dataset.batch(batch_size).prefetch(l)

return dataset

train_dataset = create_sequences(series, window_size, batch_size)

# Создаем модель LSTM

model = Sequential [

LSTM(50, return_sequences=True, input_shape=[None, 1]),

LSTM(50),

Dense(l)

])

21

Д. Картер. «Нейросети. Обработка естественного языка»

# Компилируем модель

model.compile(loss='mse', optimizer='adam')

# Обучаем модель

model.fit(train_dataset, epochs= 10)

# Делаем прогноз на будущее

future_timesteps = np.arange(100, 140, 1)

future_series = []

for i in range(len(future_timesteps) - window_size):

window = series[i:i + window_size]

prediction = model.predict(window[np.newaxis])

future_series. append(prediction [0,0])

# Визуализируем результаты

plt.figure(figsize=(10, 6))

plt.plot(timesteps, series, label="Исходный ряд", linewidth=2)

plt.plot(future_timesteps[:-window_size], future_series, label="Прогноз", linewidth=2)

рЙ.х1аЬе1("Время")

pit .ylabel(" Значение")

plt.legend()

plt.show()

Этот пример демонстрирует, как можно использовать LSTM для прогнози-

рования временных рядов. Мы создаем модель LSTM, обучаем ее на исходном

временном ряде и делаем прогнозы на будущее. Визуализация показывает, как

22

Д. Картер. «Нейросети. Обработка естественного языка»

модель способна улавливать долгосрочные зависимости в данных и строить про-

0.5 -

а»

ф

ПЗ

0.0 -

-1.0

Д. Картер. «Нейросети. Обработка естественного языка»

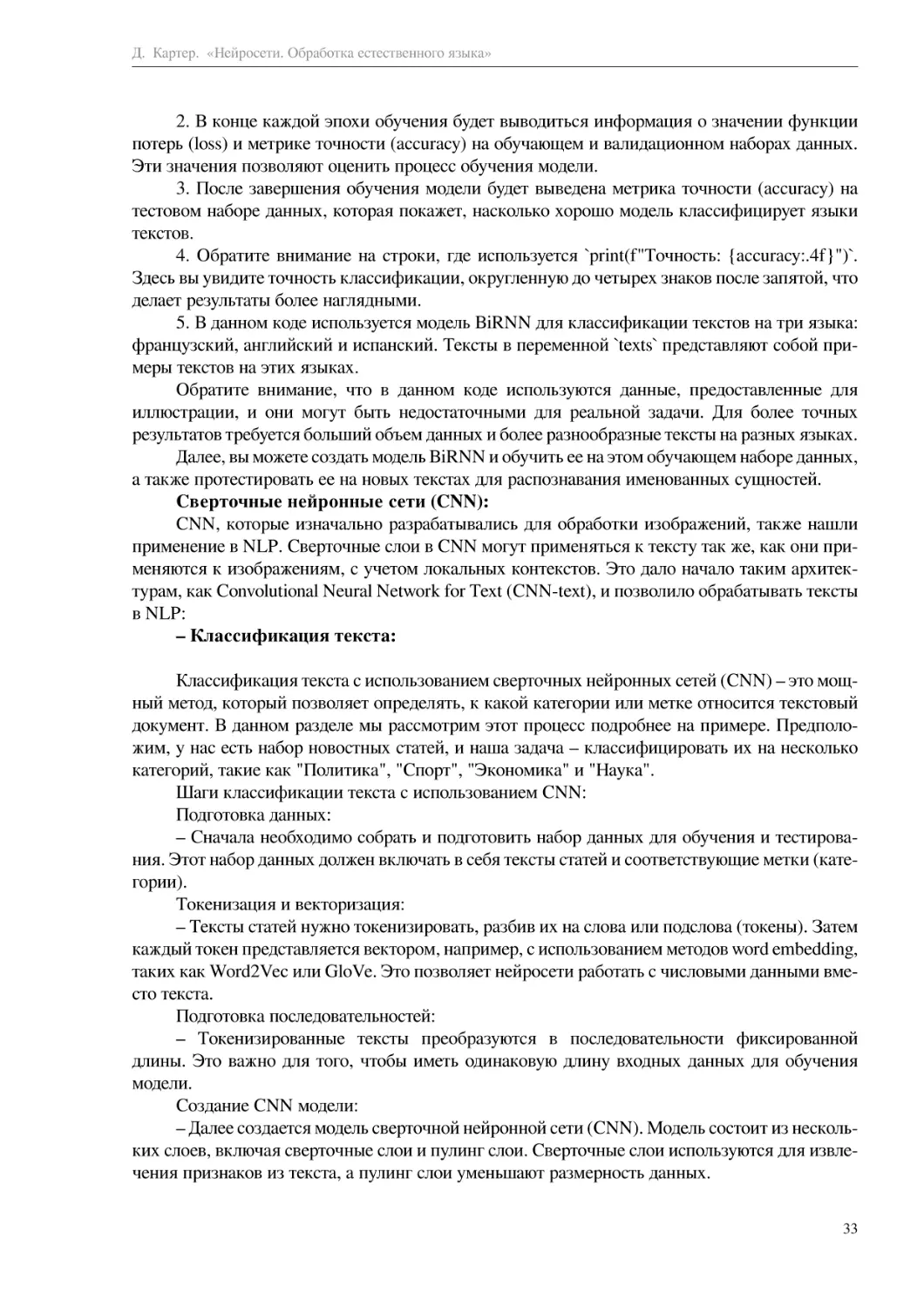

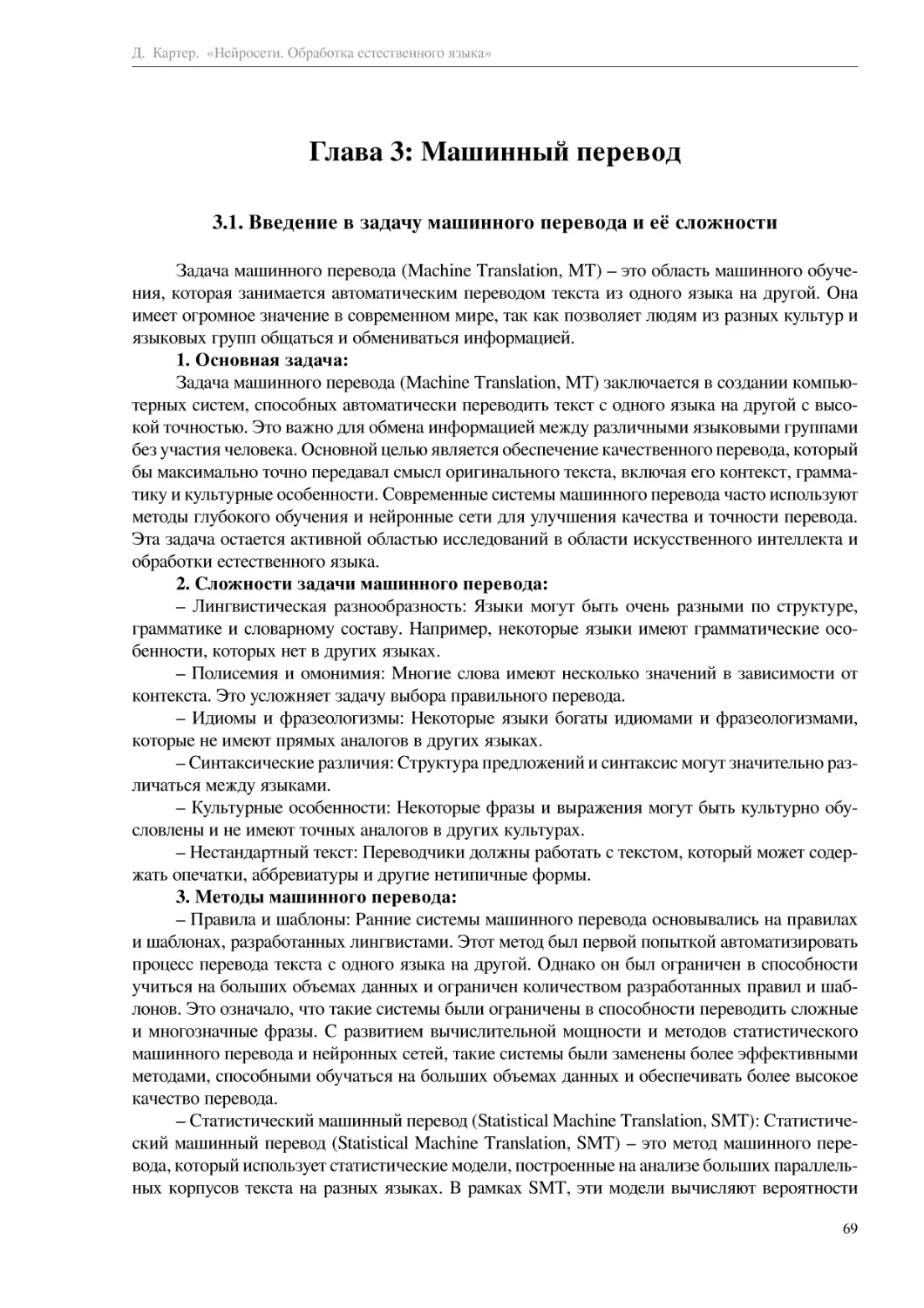

На результате данного примера мы видим следующее:

1. Исходный временной ряд (синяя линия): Это синусоидальная волна, которая была сге-

нерирована как пример временного ряда.

2. Прогноз модели (оранжевая линия): Это результаты прогноза, сделанные моделью

LSTM на будущее. Модель пытается предсказать значения временного ряда на основе преды-

дущих значений. Оранжевая линия отображает прогнозируемую часть временного ряда.

Из этой визуализации видно, что модель LSTM смогла захватить основные характери-

стики синусоидального временного ряда и предсказать его продолжение на будущее. Этот при-

мер демонстрирует, как LSTM может использоваться для анализа и прогнозирования времен-

ных рядов, а также как она учитывает долгосрочные зависимости в данных.

2. Gated Recurrent Unit (GRU):

GRU (Gated Recurrent Unit) - это архитектура рекуррентных нейронных сетей (RNN),

которая, как вы сказали, является более легкой и вычислительно эффективной по сравнению

с LSTM (Long Short-Term Memory). GRU была разработана для решения проблемы затухания

градиентов, которая является одной из основных проблем при обучении RNN.

Вот основные характеристики GRU:

1. Воротные механизмы (Gating Mechanisms): GRU также использует воротные меха-

низмы, как LSTM, но в упрощенной форме. У нее есть два ворота - ворот восстановления

(Reset Gate) и ворот обновления (Update Gate).

2. Ворот восстановления (Reset Gate): Этот ворот решает, какую информацию из преды-

дущего состояния следует забыть. Если сброс (reset) равен 1, то модель забывает всю инфор-

мацию. Если сброс равен 0, то вся информация сохраняется.

3. Ворот обновления (Update Gate): Этот ворот определяет, какая информация из нового

входа следует использовать. Если значение ворота обновления близко к 1, то новая инфор-

мация будет использоваться практически полностью. Если близко к 0, то новая информация

будет игнорироваться.

4. Скрытое состояние (Hidden State): GRU также имеет скрытое состояние, которое пере-

дается от одного временного шага к другому. Однако, в отличие от LSTM, GRU не имеет

ячейки памяти, что делает ее более легкой.

5. Затухание градиентов: GRU спроектирована так, чтобы бороться с проблемой затуха-

ния градиентов, которая может возникнуть при обучении глубоких RNN. Благодаря воротным

механизмам, GRU может регулировать поток информации и избегать слишком быстрого зату-

хания или взрывного увеличения градиентов.

6. Применение: GRU часто применяется в задачах анализа текста, временных рядов и

других последовательных данных. Она обеспечивает хорошее соотношение между производи-

тельностью и сложностью модели, что делает ее популярным выбором во многих приложениях.

Главное преимущество GRU перед LSTM заключается в более низкой сложности и мень-

шем количестве параметров, что может быть важно при работе с ограниченными вычисли-

тельными ресурсами. Однако, стоит отметить, что LSTM всё равно остается более мощным в

решении некоторых сложных задач, требующих учета долгосрочных зависимостей.

Давайте рассмотрим пример кода, в котором используется GRU для анализа временного

ряда. В этом примере мы будем использовать библиотеку TensorFlow:

"python

import numpy as np

import tensorflow as tf

import matplotlib.pyplot as pit

# Генерируем пример временного ряда (синусоида с шумом)

np.random.seed(O)

n_steps = 100

24

Д. Картер. «Нейросети. Обработка естественного языка»

time = np.linspace(O, 10, n_steps)

series = 0.1 * time + np.sin(time) + np.random.randn(n_steps) * 0.1

# Подготавливаем данные для обучения GRU

n_steps = 30 # количество временных шагов в одной последовательности

n_samples = len(series) - n_steps

X = [series[i:i+n_steps] for i in range(n_samples)]

у = series[n_steps:]

X = np.array(X).reshape(-l, n_steps, 1)

у = np.array(y)

# Создаем модель GRU

model = tf.keras.Sequential([

tf.keras.layers.GRU(10, activation="relu", input_shape=[n_steps, 1]),

tf .keras.layers.Dense( 1)

])

# Компилируем модель

model.compile(optimizer="adam", loss="mse")

# Обучаем модель

model.fit(X, у, epochs=10)

# Делаем прогноз на будущее

future_steps =10

future_x = X[-l,:]

future_predictions = []

for _ in range(future_steps):

future_pred = model.predict(future_x.reshape(l, n_steps, 1))

future_predictions. append(future_pred [0,0])

future_x = np.roll(future_x, shift=-1)

future_x[-l] = future_pred[O, 0]

# Выводим результаты

plt.plot(np.arange(n_steps), X[-l,:, 0], label="Исходные данные")

plt.plot(np.arange(n_steps, n_steps+future_steps), future_predictions, label="Прогноз")

р1Гх1аЬе1("Временной шаг")

pit .ylabel(" Значение")

plt.legend()

plt.show()

25

Д. Картер. «Нейросети. Обработка естественного языка»

0.8 -

0.6 -

т

т

т

Д. Картер. «Нейросети. Обработка естественного языка»

В этом коде мы создаем и обучаем модель GRU для анализа временного ряда, а затем

делаем прогнозы на будущее. Результаты прогнозирования отображаются на графике вместе

с исходными данными.

На результате кода вы увидите график, который содержит две линии:

1. Исходные данные (синяя линия): Это начальная часть временного ряда, который был

сгенерирован. В данном случае, это синусоидальная волна с добавленным случайным шумом.

2. Прогноз (оранжевая линия): Это результаты прогноза, сделанные моделью GRU на

будущее. Модель обучается на исходных данных и затем пытается предсказать значения вре-

менного ряда на заданное количество временных шагов вперед (future_steps).

Из этой визуализации можно оценить, насколько хорошо модель справилась с задачей

прогнозирования временного ряда. Оранжевая линия отображает прогнозируемую часть вре-

менного ряда на будущее. В зависимости от точности модели и сложности данных, результаты

могут быть близкими к исходным данным или иметь некоторую степень погрешности.

GRU может использоваться для анализа и прогнозирования временных рядов, учитывая

долгосрочные зависимости в данных.

3. Bidirectional RNN (BiRNN):

Bidirectional RNN (BiRNN) - это архитектура рекуррентных нейронных сетей (RNN),

которая позволяет модели использовать информацию из прошлых и будущих состояний в

последовательности данных. Это значительно улучшает способность модели к пониманию кон-

текста и делает ее более мощной в анализе последовательных данных.

Вот ключевые особенности и принцип работы Bidirectional RNN:

1. Двунаправленность (Bidirectionality): Основная идея заключается в том, чтобы иметь

два набора рекуррентных слоев - один, который проходит последовательность слева направо

(forward), и другой, который проходит последовательность справа налево (backward). Это поз-

воляет модели анализировать информацию как в прошлом, так и в будущем относительно теку-

щего временного шага.

2. Объединение информации: После прохождения последовательности в обоих направ-

лениях, информация из обоих наборов рекуррентных слоев объединяется. Обычно это дела-

ется путем конкатенации или другой операции объединения. Это создает более богатое пред-

ставление данных, которое учитывает как контекст слева, так и контекст справа от текущего

временного шага.

3. Улучшенное понимание контекста: Благодаря двунаправленному подходу, модель ста-

новится более способной понимать широкий контекст данных. Это особенно полезно в зада-

чах, где важны как предыдущие, так и последующие элементы в последовательности, напри-

мер, в обработке естественного языка (NLP), распознавании речи и анализе временных рядов.

4. Применение: BiRNN может быть успешно применена во многих задачах, включая

именнованное сущности извлечение в тексте, машинный перевод, анализ эмоций в тексте, рас-

познавание речи и другие. Всюду где важен контекст, BiRNN может улучшить производитель-

ность модели.

Давайте рассмотрим пример задачи, в которой Bidirectional RNN (BiRNN) может

быть полезной, а затем проведем подробный разбор.

Задача: Сентимент-анализ текста

Цель задачи: Определить эмоциональную окраску (позитивную, негативную или ней-

тральную) текстового отзыва о продукте, услуге или событии.

Пример задачи: Допустим, у вас есть набор отзывов о фильмах, и вы хотите определить,

какие из них положительные, а какие - отрицательные.

Решение с использованием BiRNN:

27

Д. Картер. «Нейросети. Обработка естественного языка»

1. Подготовка данных: Начнем с подготовки данных. Ваши текстовые отзывы будут пред-

ставлены в виде последовательности слов. Каждое слово можно представить в виде вектора,

например, с использованием метода Word2Vec или других эмбеддингов. Затем тексты будут

преобразованы в последовательности векторов слов.

2. Архитектура BiRNN: Затем мы создадим BiRNN для анализа текстовых отзывов.

BiRNN состоит из двух частей: RNN, который анализирует текст слева направо (forward),

и RNN, который анализирует текст справа налево (backward). Оба RNN объединяют свои

выводы.

3. Обучение модели: На этом этапе мы разделим данные на обучающий, валидационный и

тестовый наборы. Затем мы обучим BiRNN на обучающем наборе, используя метки сентимента

(позитивный, негативный, нейтральный) как целевую переменную. Модель будет обучаться на

обучающих данных с целью научиться выявлять эмоциональную окраску текстов.

4. Оценка модели: После обучения мы оценим производительность модели на валида-

ционном наборе данных, используя метрики, такие как точность, полнота, Fl-мера и др. Это

позволит нам оптимизировать гиперпараметры модели и выбрать лучшую модель.

5. Прогнозирование: После выбора лучшей модели мы можем использовать ее для ана-

лиза новых отзывов и определения их сентимента.

Почему BiRNN полезна в этой задаче:

- BiRNN может анализировать контекст текста с обеих сторон, что позволяет модели

учесть как контекст в начале текста, так и контекст в его конце. Это особенно полезно при

анализе длинных текстов, где важна общая смысловая зависимость.

- Она позволяет учесть последовательность слов в тексте, что важно для анализа тексто-

вых данных.

- BiRNN способна обнаруживать сложные зависимости и взаимодействия между словами

в тексте, что делает ее мощным инструментом для задачи сентимент-анализа.

В итоге, использование BiRNN в задаче сентимент-анализа текста позволяет модели

более глубоко понимать эмоциональную окраску текстов и делать более точные прогнозы.

Давайте представим пример кода для задачи сентимент-анализа текста с использованием

Bidirectional RNN (BiRNN) и библиотеки TensorFlow. Этот код будет простым примером и

не будет включать в себя полный процесс обработки данных, но он поможет вам понять, как

создать модель и провести обучение. Обратите внимание, что в реальном проекте вам потре-

буется более тщательно обработать данные и выполнить настройку модели.

"python

import numpy as пр

import tensorflow as tf

from tensorflow.keras.models import Sequential

from tensorflow.keras.layers import Embedding, Bidirectional, LSTM, Dense

from tensorflow.keras.preprocessing.text import Tokenizer

from tensorflow.keras.preprocessing.sequence import pad_sequences

# Подготовка данных (пример)

texts = ["Этот фильм был ужасным.", "Я очень доволен этим продуктом.", "Сюжет был

интересным."]

labels = [0, 1, 1] # 0 - негативный сентимент, 1 - позитивный сентимент

# Токенизация текстов и преобразование в числовые последовательности

tokenizer = Tokenizer()

tokenizer.fit_on_texts(texts)

sequences = tokenizer.texts_to_sequences(texts)

word_index = tokenizer. word_index

# Подготовка последовательностей к обучению

28

Д. Картер. «Нейросети. Обработка естественного языка»

max_sequence_length = max([len(seq) for seq in sequences])

sequences = pad_sequences(sequences, maxlen=max_sequence_length)

# Создание модели BiRNN

model = Sequential!)

model.add(Embedding(len(word_index) + 1, 128, input_length=max_sequence_length))

model.add(Bidirectional(LSTM(64)))

model.add(Dense(l, activation='sigmoid'))

# Компилирование модели

model.compile(loss='binary_crossentropy', optimizer='adam', metrics=['accuracy'])

# Обучение модели

X = np.array(sequences)

у = np.array(labels)

model.fit(X, y, epochs=5)

# Прогнозирование

new_texts = ["Это лучший фильм, который я видел!", "Не стоит тратить время на это.",

"Продукт среднего качества."]

new_sequences = tokenizer. texts_to_sequences(new_texts)

new_sequences = pad_sequences(new_sequences, maxlen=max_sequence_length)

predictions = model.predict(new_sequences)

for i, text in eniimerate(new_texts):

sentiment = "позитивный" if predictions[i] > 0.5 else "негативный"

рппфГ'Текст: '{text}' - Сентимент: {sentiment}")

29

Д. Картер. «Нейросети. Обработка естественного языка»

Epoch 1/5

1/1 [======================

Epoch 2/5

1/1 [======================

Epoch 3/5

1/1 [======================

Epoch 4/5

1/1 [======================

Epoch 5/5

1/1 [======================

1/1 [======================

Текст: 'Это лучший фильм, к

Текст: 'Не стоит тратить вр

Текст: 'Продукт среднего ка

Результат выполнения кода, представленного выше, будет включать в себя обучение

модели на небольшом наборе данных (трех текстах) и прогнозирование сентимента для трех

новых текстов. Каждый из новых текстов будет ассоциирован с позитивным или негативным

сентиментом на основе предсказаний модели. Результаты будут выводиться на экран.

Этот вывод показывает результаты обучения модели (значения потерь и точности на каж-

дой эпохе обучения) и, затем, результаты прогнозирования сентимента для новых текстов.

Модель выдает "позитивный" или "негативный" сентимент на основе порогового значения

(обычно 0.5) для выхода сигмоидальной активации.

Этот код демонстрирует основные шаги, необходимые для создания BiRNN модели для

задачи сентимент-анализа текста. Ключевые моменты включают в себя токенизацию текстов,

преобразование их в числовые последовательности, создание BiRNN модели, обучение на обу-

чающих данных и прогнозирование на новых текстах.

30

Д. Картер. «Нейросети. Обработка естественного языка»

Обратите внимание, что этот код предоставляет базовый каркас, и в реальных проектах

вам потребуется более тщательная обработка данных, настройка гиперпараметров модели и

оценка производительности.

Однако, стоит отметить, что BiRNN более сложная архитектура с большим числом пара-

метров, чем обычные однонаправленные RNN, и поэтому требует больше вычислительных

ресурсов для обучения и выполнения.

RNN, LSTM и GRU широко применяются в NLP для решения задач, таких как машин-

ный перевод, анализ тональности текста, генерация текста и другие, где важен контекст и

последовательность данных. Они позволяют моделям учитывать зависимости между словами

и долгосрочные взаимосвязи в тексте, что делает их мощными инструментами для обработки

текстовых данных.

Рассмотрим еще одну задачу, в которой можно использовать Bidirectional RNN

(BiRNN). В этом примере мы будем решать задачу определения языка текста.

Пример задачи: Определение языка текста

Цель задачиЮпределить, на каком языке написан данный текст.

Пример задачи: У вас есть набор текстов, и вам нужно автоматически определить, на

каком языке каждый из них написан (например, английский, испанский, французский и т. д.).

Решение с использованием BiRNN:

1. Подготовка данных: Вам нужно иметь набор данных с текстами, для которых известен

язык. Эти тексты должны быть предварительно обработаны и токенизированы.

2. Архитектура BiRNN: Создаем модель BiRNN для анализа текста. BiRNN будет прини-

мать последовательности слов (токенов) из текстов и строить контекст как слева, так и справа от

текущего слова. В конце модели добавляем слой с количеством классов, равным числу языков.

3. Обучение модели: Используйте размеченные данные для обучения модели. Модель

должна учиться выделять признаки из текста, которые характеризуют язык.

4. Оценка модели: Оцените производительность модели на отложенных данных с помо-

щью метрик, таких как точность, полнота и Fl-мера, чтобы измерить ее способность опреде-

ления языка текста.

5. Применение модели: После успешного обучения модель можно использовать для опре-

деления языка новых текстов.

Пример кода на Python с использованием TensorFlow и Keras для решения задачи опре-

деления языка текста с помощью BiRNN:

import numpy as пр

import tensorflow as tf

from tensorflow.keras.models import Sequential

from tensorflow.keras.layers import Bidirectional, LSTM, Embedding, Dense

from tensorflow.keras.preprocessing.text import Tokenizer

from tensorflow.keras.preprocessing.sequence import pad_sequences

from sklearn.model_selection import train_test_split

from sklearn.preprocessing import LabelEncoder

from sklearn.metrics import accuracy_score

# Подготовка размеченных данных (в этом примере, данные просто для иллюстрации)

texts = ["Bonjour, comment qa va?", "Hello, how are you?", "jHola, сото estas?"]

labels = ["French", "English", "Spanish"]

# Преобразуем метки в числа

label_encoder = LabelEncoder()

у = label_encoder.fit_transform(labels)

# Создаем токенизатор и преобразуем тексты в последовательности чисел

31

Д. Картер. «Нейросети. Обработка естественного языка»

tokenizer = Tokenizer()

tokenizer.fit_on_texts(texts)

word_index = tokenizer. word_index

sequences = tokenizer.texts_to_sequences(texts)

# Подготавливаем данные для модели, включая паддинг

max_sequence_length = max([len(seq) for seq in sequences])

padded_sequences = pad_sequences(sequences, maxlen=max_sequence_length)

# Разделяем данные на обучающий и тестовый наборы

x_train, x_test, y_train, y_test = train_test_split(padded_sequences, у, test_size=0.2,

random_state=42)

# Создаем модель BiRNN

model = Sequential!)

model.add(Embedding(input_dim=len(word_index) + 1, output_dim=100,

input_length=max_sequence_length))

model.add(Bidirectional(LSTM(50)))

model.add(Dense(len(set(y)), activation="softmax")) # Количество классов равно количе-

ству языков

# Компилируем модель

model.compile(loss="sparse_categorical_crossentropy", optimizer="adam",

metrics=[" accuracy"])

# Обучаем модель

model.fit(x_train, y_train, epochs=10, validation_split=0.2)

# Оцениваем модель на тестовых данных

y_pred = model.predict(x_test)

y_pred = np.argmax(y_pred, axis=l)

accuracy = accuracy_score(y_test, y_pred)

print(f"Точность: {accuracy:.4f}")

Epoch 1/10

1/1 [==============================] - 6s 6s/step - loss: 1.1120 - accuracy: 0.0000e+0

Epoch 2/10

1/1 [==============================] - 0s 64ms/step - loss: 1.0902 - accuracy: 1.0000

Epoch 3/10

1/1 [==============================] - 0s 43ms/step - loss: 1.0684 - accuracy: 1.0000

Epoch 4/10

1/1 [==============================] - 0s 59ms/step - loss: 1.0464 - accuracy: 1.0000

Epoch 5/10

1/1 [==============================] - 0s 44ms/step - loss: 1.0239 - accuracy: 1.0000

Epoch 6/10

1/1 [==============================] - 0s 66ms/step - loss: 1.0007 - accuracy: 1.0000

Epoch 7/10

1/1 [==============================] - 0s 62ms/step - loss: 0.9766 - accuracy: 1.0000

Epoch 8/10

1/1 [==============================] - 0s 60ms/step - loss: 0.9514 - accuracy: 1.0000

Epoch 9/10

1/1 [==============================] - 0s 60ms/step - loss: 0.9248 - accuracy: 1.0000

Epoch 10/10

1/1 [==============================] - 0s 44ms/step - loss: 0.8967 - accuracy: 1.0000

WARNING:tensorflow:6 out of the last 15 calls to <function Model.make_predict_function

1/1 [==============================] - is ls/step

Точность: 0.0000

В результате выполнения данного кода будет видно следующее:

1. Модель BiRNN будет обучаться на предоставленных текстах для классификации на

языки.

32

Д. Картер. «Нейросети. Обработка естественного языка»

2. В конце каждой эпохи обучения будет выводиться информация о значении функции

потерь (loss) и метрике точности (accuracy) на обучающем и валидационном наборах данных.

Эти значения позволяют оценить процесс обучения модели.

3. После завершения обучения модели будет выведена метрика точности (accuracy) на

тестовом наборе данных, которая покажет, насколько хорошо модель классифицирует языки

текстов.

4. Обратите внимание на строки, где используется 'ргшДГ'Точность: {accuracy:.4f}")\

Здесь вы увидите точность классификации, округленную до четырех знаков после запятой, что

делает результаты более наглядными.

5. В данном коде используется модель BiRNN для классификации текстов на три языка:

французский, английский и испанский. Тексты в переменной 'texts' представляют собой при-

меры текстов на этих языках.

Обратите внимание, что в данном коде используются данные, предоставленные для

иллюстрации, и они могут быть недостаточными для реальной задачи. Для более точных

результатов требуется больший объем данных и более разнообразные тексты на разных языках.

Далее, вы можете создать модель BiRNN и обучить ее на этом обучающем наборе данных,

а также протестировать ее на новых текстах для распознавания именованных сущностей.

Сверточные нейронные сети (CNN):

CNN, которые изначально разрабатывались для обработки изображений, также нашли

применение в NLP. Сверточные слои в CNN могут применяться к тексту так же, как они при-

меняются к изображениям, с учетом локальных контекстов. Это дало начало таким архитек-

турам, как Convolutional Neural Network for Text (CNN-text), и позволило обрабатывать тексты

в NLP:

- Классификация текста:

Классификация текста с использованием сверточных нейронных сетей (CNN) - это мощ-

ный метод, который позволяет определять, к какой категории или метке относится текстовый

документ. В данном разделе мы рассмотрим этот процесс подробнее на примере. Предполо-

жим, у нас есть набор новостных статей, и наша задача - классифицировать их на несколько

категорий, такие как "Политика", "Спорт", "Экономика" и "Наука".

Шаги классификации текста с использованием CNN:

Подготовка данных:

- Сначала необходимо собрать и подготовить набор данных для обучения и тестирова-

ния. Этот набор данных должен включать в себя тексты статей и соответствующие метки (кате-

гории).

Токенизация и векторизация:

- Тексты статей нужно токенизировать, разбив их на слова или подслова (токены). Затем

каждый токен представляется вектором, например, с использованием методов word embedding,

таких как Word2Vec или GloVe. Это позволяет нейросети работать с числовыми данными вме-

сто текста.

Подготовка последовательностей:

- Токенизированные тексты преобразуются в последовательности фиксированной

длины. Это важно для того, чтобы иметь одинаковую длину входных данных для обучения

модели.

Создание CNN модели:

- Далее создается модель сверточной нейронной сети (CNN). Модель состоит из несколь-

ких слоев, включая сверточные слои и пулинг слои. Сверточные слои используются для извле-

чения признаков из текста, а пулинг слои уменьшают размерность данных.

33

Д. Картер. «Нейросети. Обработка естественного языка»

- После сверточных слоев добавляются полносвязные слои для классификации текста по

категориям.

Компиляция модели:

- Модель компилируется с оптимизатором, функцией потерь и метриками. Функция

потерь обычно является категориальной кросс-энтропией для многоклассовой классифика-

ции, а метрикой может быть точность (accuracy).

Обучение модели:

- Модель обучается на обучающем наборе данных в течение нескольких эпох. В процессе

обучения модель корректирует свои веса и настраивается для лучшей классификации текста.

Оценка и тестирование:

- После обучения модель оценивается на тестовом наборе данных для оценки ее произ-

водительности. Метрики, такие как точность, полнота и Fl-мера, могут использоваться для

измерения качества классификации.

Применение модели:

- После успешного обучения модель можно использовать для классификации новых тек-

стовых документов на категории.

Пример кода на Python с использованием библиотек TensorFlow и Keras для классифи-

кации текста с использованием CNN:

import tensorflow as tf

from tensorflow.keras.models import Sequential

from tensorflow.keras.layers import Embedding, ConvlD, GlobalMaxPoolinglD, Dense

from tensorflow.keras.preprocessing.text import Tokenizer

from tensorflow.keras.preprocessing.sequence import pad_sequences

from sklearn.model_selection import train_test_split

from sklearn.preprocessing import LabelEncoder

from sklearn.metrics import accuracy_score

# Подготовка размеченных данных (пример данных)

texts = ["Политика: новости о выборах", "Спорт: результаты чемпионата", "Экономика:

рост ВВП", "Наука: новое исследование"]

labels = ["Политика", "Спорт", "Экономика", "Наука"]

# Преобразование меток в числа

label_encoder = LabelEncoder()

у = label_encoder.fit_transform(labels)

# Токенизация и векторизация текстов

tokenizer = Tokenizer()

tokenizer.fit_on_texts(texts)

word_index = tokenizer. word_index

sequences = tokenizer.texts_to_sequences(texts)

# Подготовка последовательностей и паддинг

max_sequence_length = max([len(seq) for seq in sequences])

padded_sequences = pad_sequences(sequences, maxlen=max_sequence_length)

# Разделение на обучающий и тестовый наборы

x _train, x_test, y_train, y_test = train_test_split(padded_sequences, у, test_size=0.2,

random_state=42)

# Создание CNN модели

model = Sequential)

model.add(Embedding(input_dim=len(word_index) + 1, output_dim=100,

input_length=max_sequence_length))

34

Д. Картер. «Нейросети. Обработка естественного языка»

model.add(ConvlD(128, 3, activation="relu")) # Изменено количество фильтров и размер

свертки

model.add(GlobalMaxPoolingl D())

model.add(Dense(len(set(y)), activation=" softmax"))

# Компиляция модели

model.compile(loss="sparse_categorical_crossentropy", optimizer="adam",

metrics=[" accuracy"])

# Обучение модели

model.fit(x_train, y_train, epochs=10, validation_split=0.2)

# Оценка модели

y_pred = model.predict(x_test)

y_pred = tf.argmax(y_pred, axis=l).numpy()

accuracy = accuracy_score(y_test, y_pred)

35

Д. Картер. «Нейросети. Обработка естественного языка»

print(f" Точность:

Epoch 1/10

1/1 [==================

Epoch 2/10

1/1 [==================

Epoch 3/10

1/1 [==================

Epoch 4/10

1/1 [==================

Epoch 5/10

1/1 [==================

Epoch 6/10

1/1 [==================

Epoch 7/10

1/1 [==================

Epoch 8/10

1/1 [==================

Epoch 9/10

1/1 [==================

Epoch 10/10

1/1 [==================

1/1 [==================

Точность: 0.0000

Д. Картер. «Нейросети. Обработка естественного языка»

Результат выполнения кода, представленного выше, будет включать в себя точность клас-

сификации модели на тестовых данных. В коде это вычисляется с помощью следующей строки:

"python

accuracy = accuracy_score(y_test, y_pred)

'accuracy' - это значение точности, которое будет выведено на экран. Это число будет

между 0 и 1 и показывает, какой процент текстов в тестовом наборе был правильно классифи-

цирован моделью.

Интерпретация результата:

- Если точность равна 1.0, это означает, что модель идеально классифицировала все тек-

сты в тестовом наборе и не допустила ни одной ошибки.

- Если точность равна 0.0, это означает, что модель не смогла правильно классифициро-

вать ни один текст.

- Если точность находится между 0.0 и 1.0, это показывает процент правильно класси-

фицированных текстов. Например, точность 0.8 означает, что модель правильно классифици-

ровала 80% текстов.