Текст

П Я. • М | п П

КО HI ЧНЫЕ

ЦЕПИ

МАРКОВА

ДЖОН ДЖ. КЕМЕНИ

ДЖ. ЛОРИ СНЕЛЛ

КОНЕЧНЫЕ

ЦЕПИ

МАРКОВА

Перевод с английского

С. А. МОЛЧАНОВА, Н. Б. ЛЕВИНОЙ

и Я. А. КОГАНА

Под редакцией

А. А. ЮШКЕВИЧА

ИЗДАТЕЛЬСТВО «НАУКА»

ГЛАВНАЯ РЕДАКЦИЯ

ФИЗИКО-МАТЕМАТИЧЕСКОЙ ЛИТЕРАТУРЫ

МОСК ВА 1970

517.8

К 35

УДК 519.2

FINITE MARKOV CHAINS

by

JOHN G. KEMENY

Professor of Mathematics

Dartmouth College

J. LAURIE SNELL

Associate Professor of Mathematics

Dartmouth College

THE UNIVERSITY SERIES IN

UNDERGRADUATE MATHEMATICS

Конечные цепи Маркова. Ke мен и Дж. и Снелл Дж. Глав

пая редакция физико-математической литературы изд-ва «Наука»,

1970.

В книге рассматриваются только цепи с конечным числом состоя-

ний и излагаются основные результаты теории таких цепей, имею-

щие значение в приложениях. Характерной чертой книги является

сочетание педантично строгого обоснования начальных понятий с

чрезвычайно элементарными аналитическими средствами, доступными

широкому кругу читателей. Благодаря последовательному использо-

ванию понятия резольвенты книга выгодно отличается от многих

руководств по теории вероятностей своим идейно-методическим един-

ством.

Рис. 12.

2*2*3

132-70

ОГЛАВЛЕНИЕ

Предисловие................................................6

Г л а в а I

Предварительные сведения ..................................9

1.1. Множества .....................................9

1.2. Высказывания..................................11

1.3. Отношения порядка.............................12

1.4. Отношения связи ............................ 15

1.5. Вероятностные меры............................18

1.6. Условная вероятность..........................20

1.7. Функции на пространстве возможностей..........22

1.8. Среднее значение и дисперсия функции..........24

1.9. Стохастические процессы.......................26

1.10. Суммируемость последовательностей и рядов ... 32

1.11. Матрицы.......................................33

Глава II

Основные понятия теории цепей Маркова.................. 39

2.1. Определение марковского процесса и цепи Маркова . 39

2.2. Примеры .......................................42

2.3. Связь с теорией матриц.........................48

2.4. Классификация состояний и цепей.............51

2.5. Чем мы будем заниматься........................56

Упражнения к главе II............................58

Глава III

Поглощающие цепи Маркова..................................62

3.1. Введение ......................................62

3.2. Фундаментальная матрица........................66

3.3. Приложения фундаментальной матрицы.............69

1*

4

ОГЛАВЛЕНИЕ

3.4. Примеры .......................................77

3.5. Распространение результатов....................81

Упражнения к главе III..........................89

Глава IV

Регулярные цепи Маркова..................................93

4.1. Основные теоремы...............................93

4.2. Закон больших чисел для регулярных цепей Маркова 98

4.3. Фундаментальная матрица регулярной цепи .... 100

4.4. Времена первого достижения....................104

4.5. Дисперсия времени первого достижения...........НО

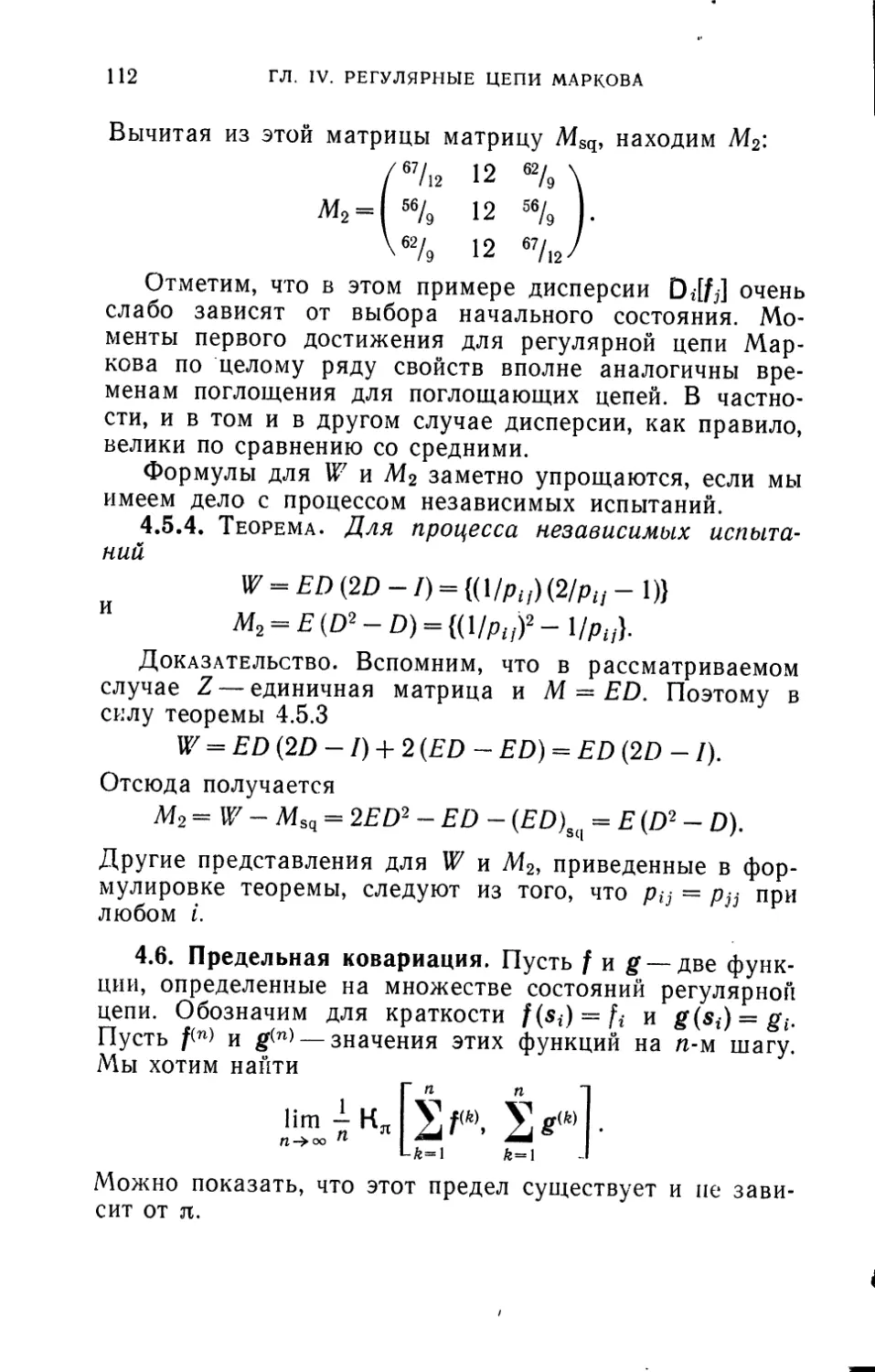

4.6. Предельная ковариация.........................112

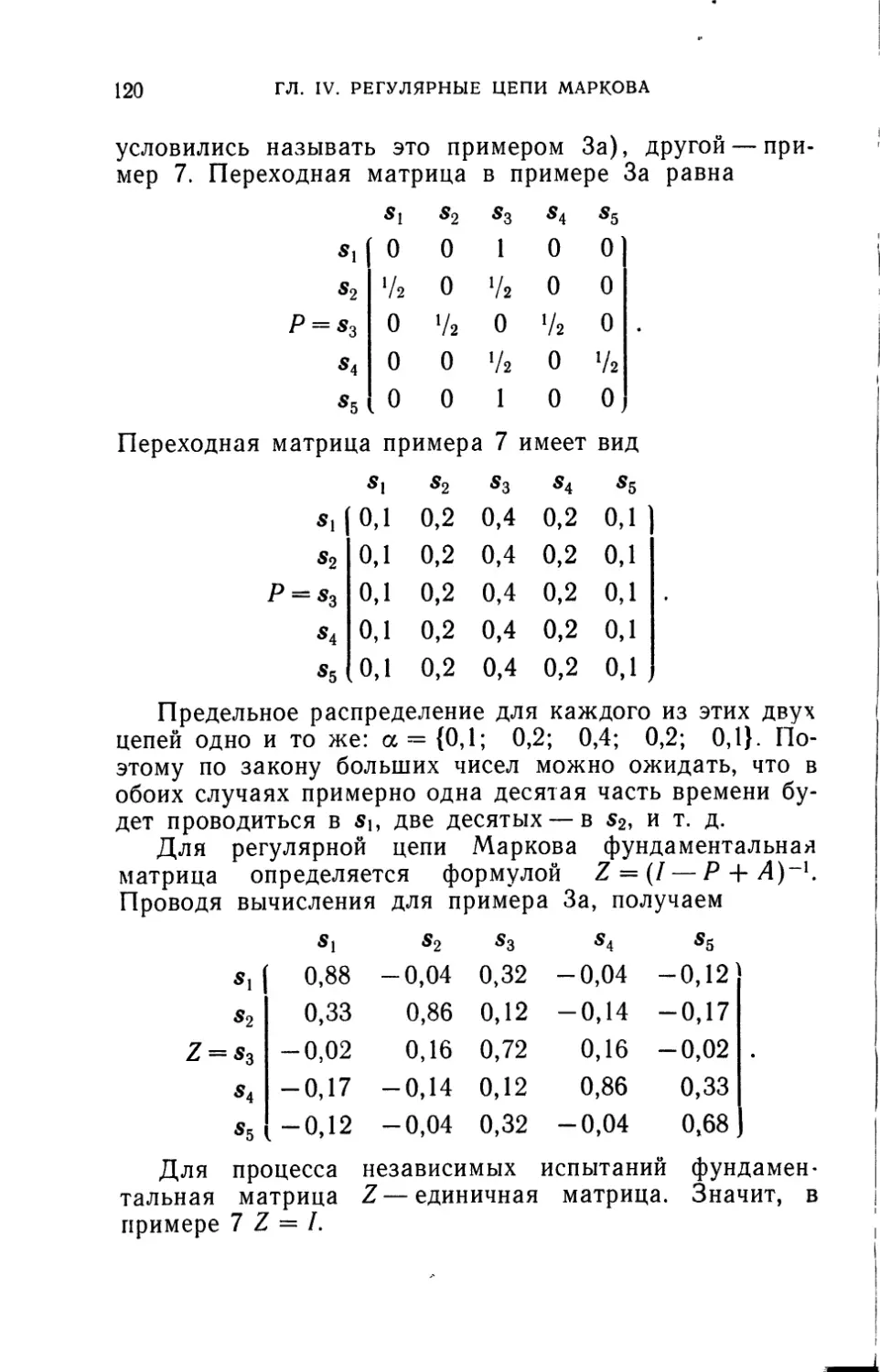

4.7. Сравнение двух примеров.......................119

4.8. Общая цепь с двумя состояниями................124

Упражнения к главе IV..........................126

Глава V

Эргодические цепи Маркова...............................129

5.1. Фундаментальная матрица.......................129

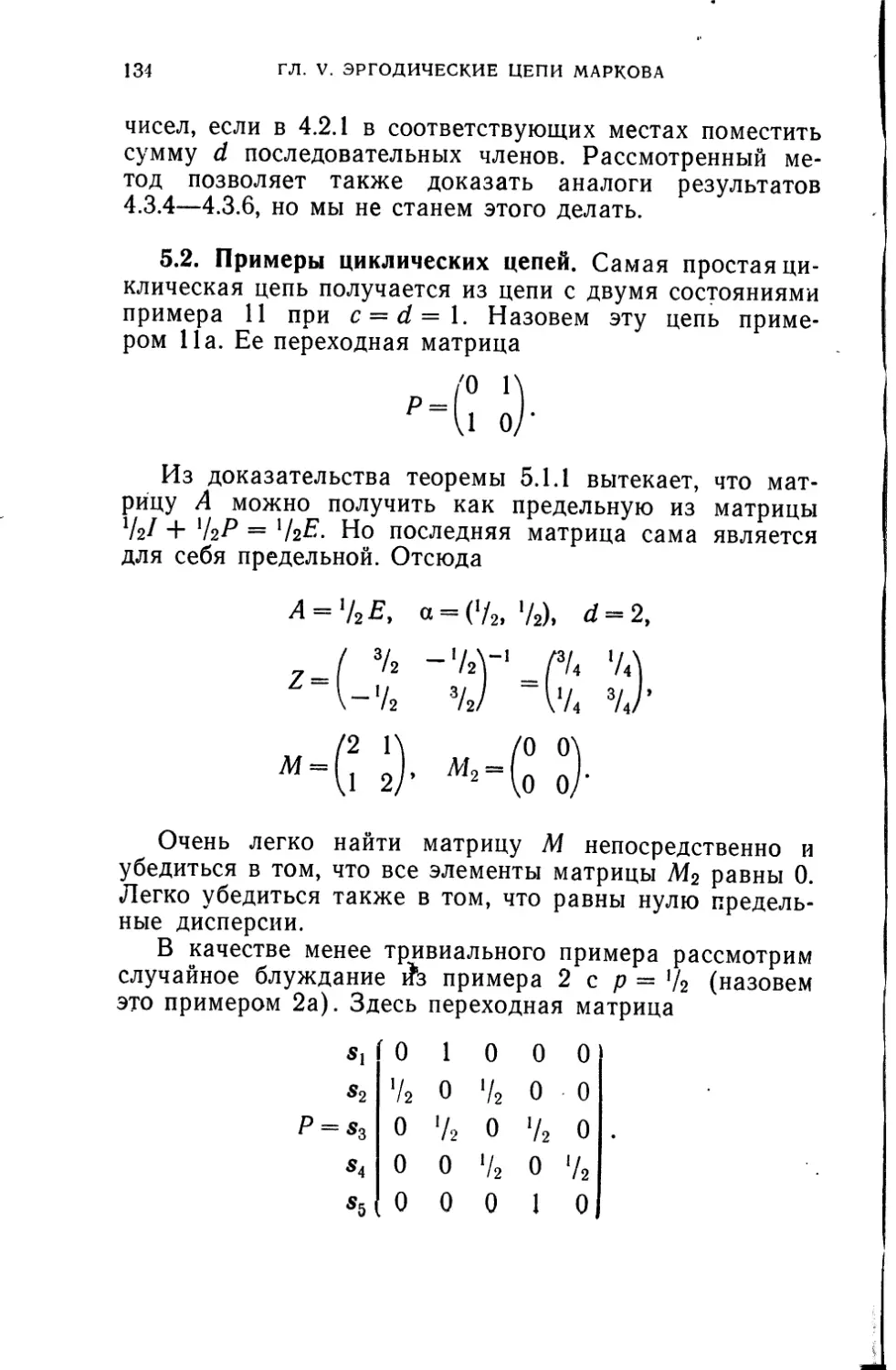

5.2. Примеры циклических цепей.....................134

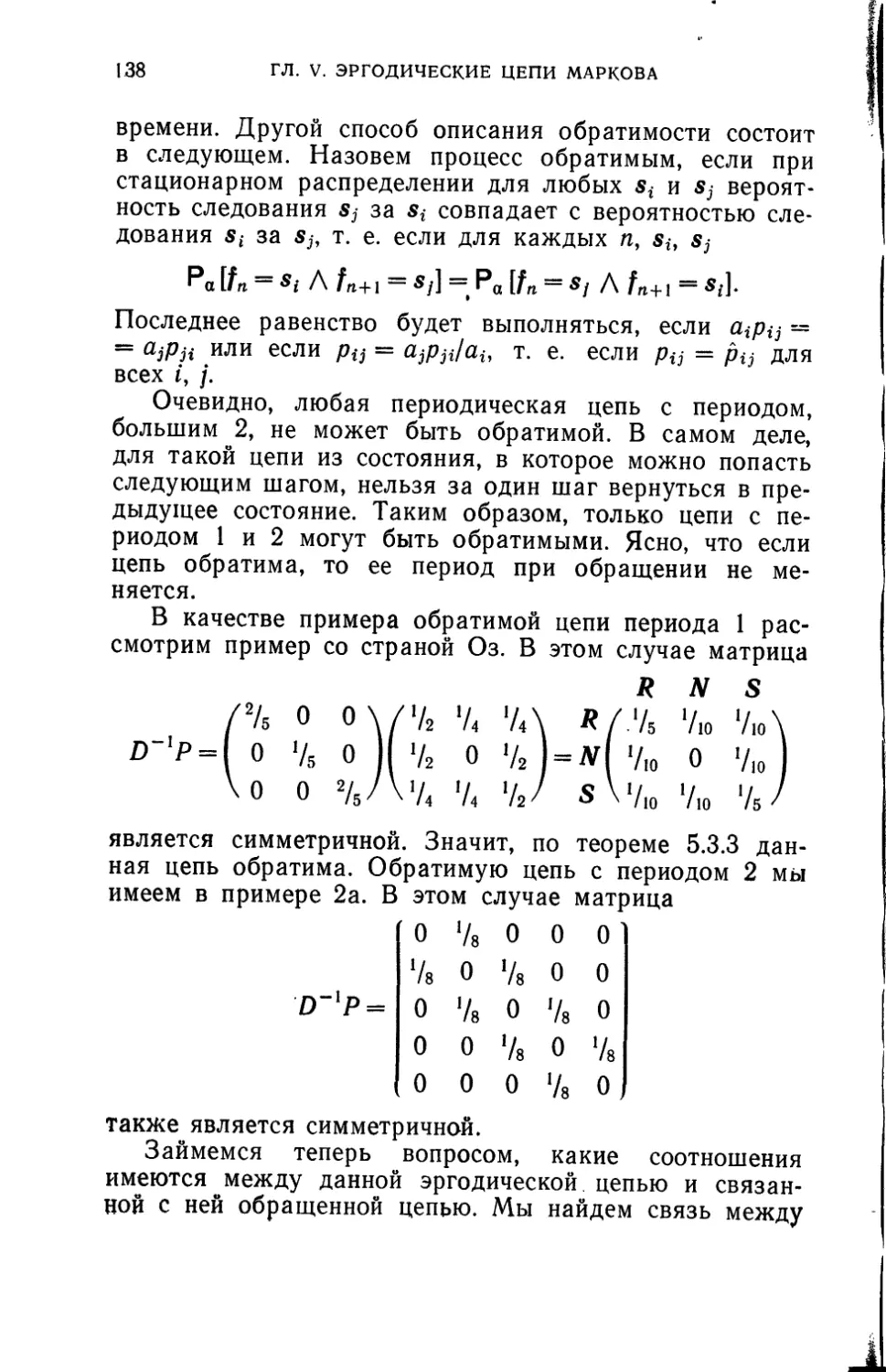

5.3. Обращенные цепи Маркова.......................136

Упражнения к главе V...........................143

Г л а в а VI

Дальнейшие результаты...................................145

6.1. Приложение теории поглощающих цепей к эргодиче-

ским цепям........................................145

6.2. Приложение теории эргодических цепей к поглощаю-

щим цепям Маркова.................................151

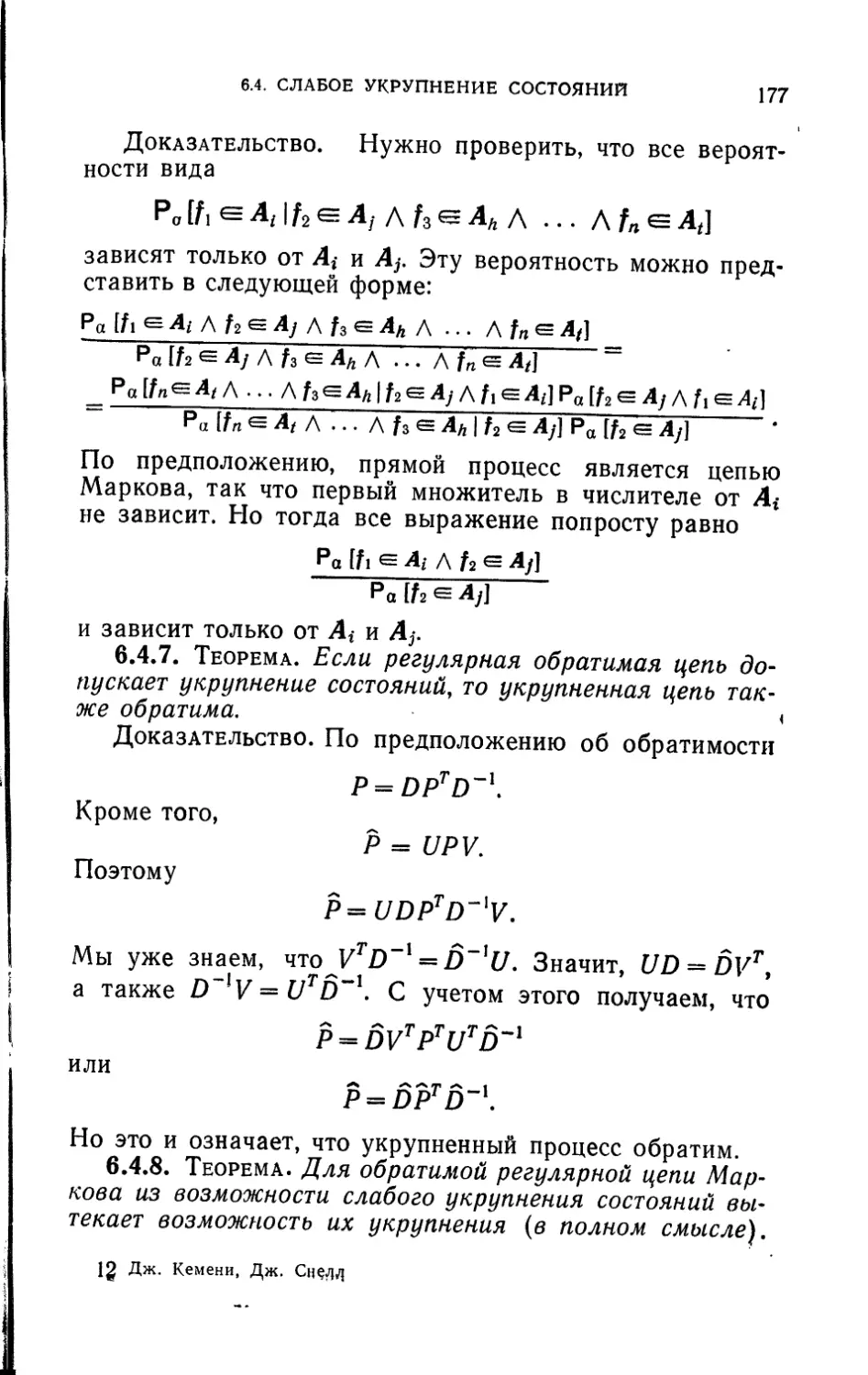

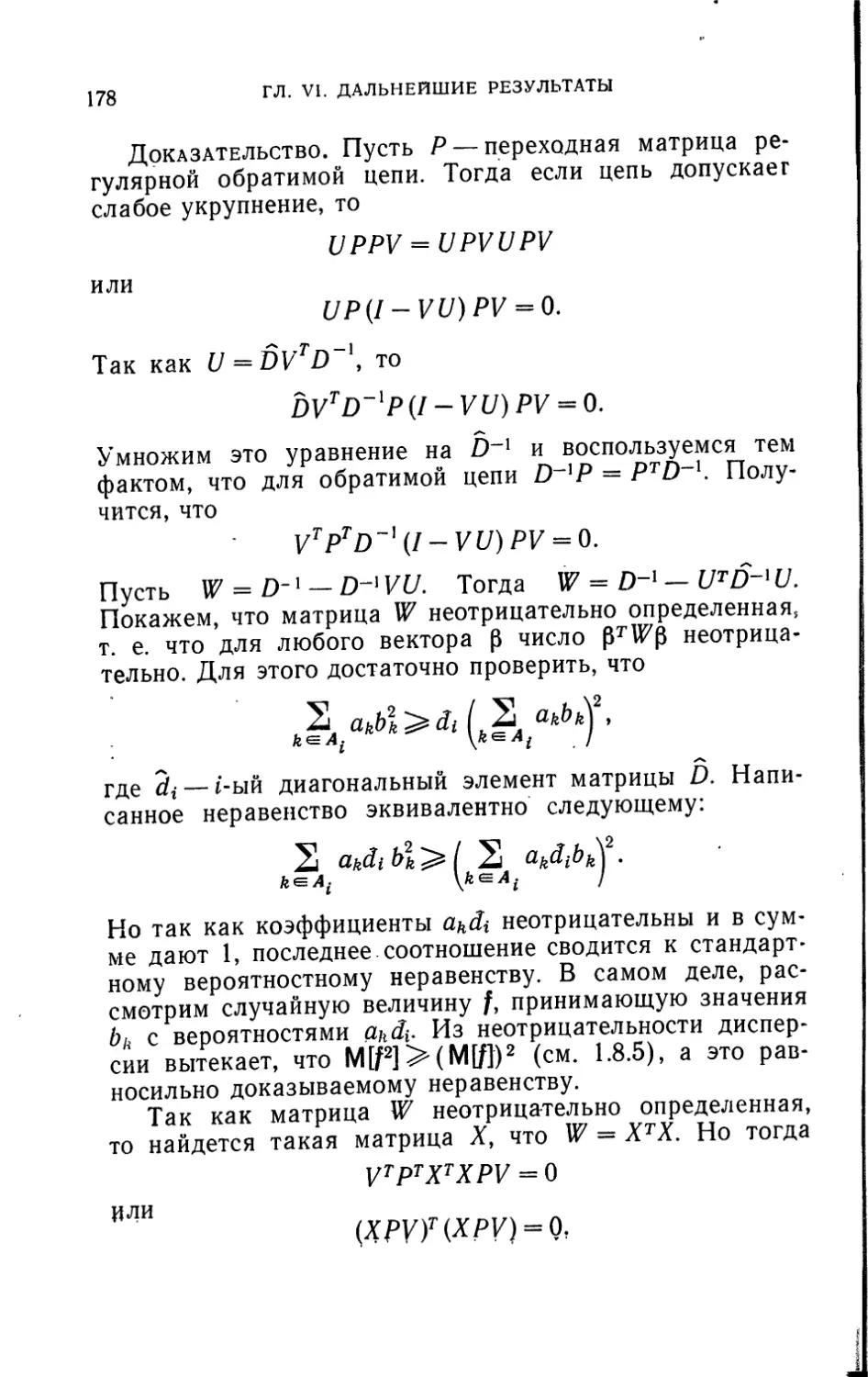

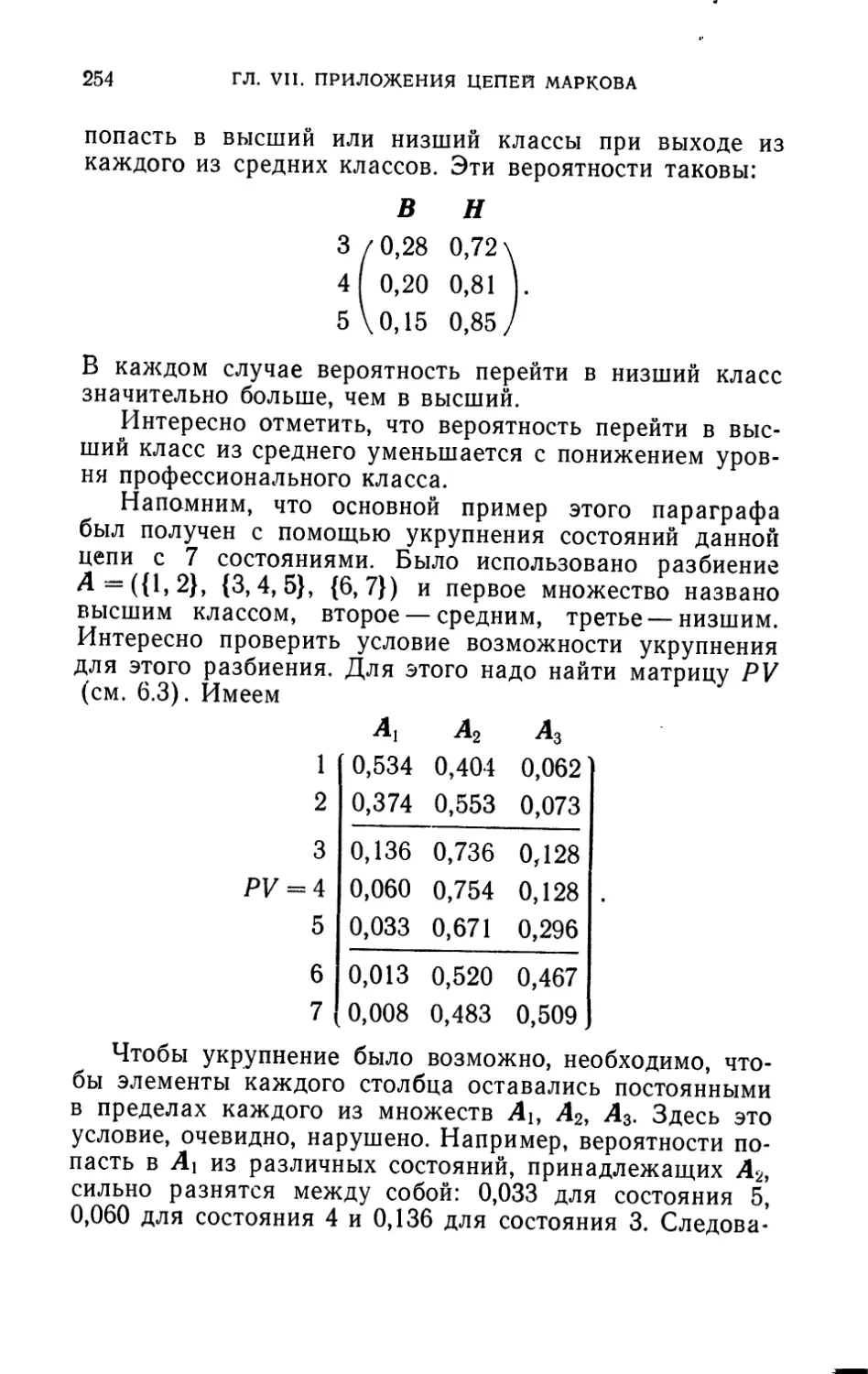

6.3. Укрупнение состояний..........................159

6.4. Слабое укрупнение состояний...................169

6.5. Расширение цепи Маркова.......................181

Упражнения к главе VI..........................187

Глава VII

Приложения цепей Маркова ........191

7.1. Случайные блуждания ..........................191

7.2. Приложения к спорту...........................208

7.3. Модель Эренфестов для диффузии 215

ОГЛАВЛЕНИЕ 5

7.4. Применения к генетике......................... 227

7.5. Теория обучения................................ 235

7.6. Применения к теории мобильности................ 246

7.7. Открытая модель Леонтьева...................... 258

Добавление................................................267

I. Сводка основных обозначений......................267

II. Основные определения...........................267

III. Основные характеристики поглощающих цепей. . . . 268

IV. Основные формулы теории поглощающих цепей . 269

V. Основные характеристики эргодических цепей .... 270

VI. Основные формулы теории эргодических цепей . . .271

ПРЕДИСЛОВИЕ

Основные понятия теории марковских цепей ввел

А. А. Марков в 1907 г. С тех пор эту теорию развивали

многие ведущие математики. В самое последнее время

обнаружилась важная роль цепей Маркова в биологи-

ческих и социологических науках. Нам представляется,

что эти новые приложения настоятельно требуют изло-

жения на английском языке основных идей теории ко-

нечных цепей Маркова.

Ограничив наше внимание случаем конечных цепей,

мы смогли дать законченное изложение предмета, тре-

бующее минимальной математической подготовки. Книга

написана с таким расчетом, чтобы ее можно было ис-

пользовать как в начальном университетском курсе тео-

рии вероятностей, так и в качестве справочника для спе-

циалцстов-нематематиков.

Благодаря тому, что в книге рассматриваются толь-

ко конечные цепи, для многих характеристик вместо

обычно употребляемых бесконечных рядов удалось дать

простые матричные выражения. Показано, что для реше-

ния всех типов задач достаточно рассмотреть только два

типа марковских цепей, а именно поглощающие и эрго-

дические цепи. Для каждого из этих двух типов цепей

вводится «фундаментальная матрица», через которую

прочие интересующие нас величины выражаются с по-

мощью элементарных матричных операций.

Одно из практических преимуществ этого нового под-

хода состоит в том, что упомянутые матричные операции

легко реализуются на быстродействующих вычислитель-

ных машинах. Авторы построили две программы для

машины ИБМ-704, по одной для каждого из двух основ-

ных типов цепей. Эти программы позволяют непосред-

ственно по переходной матрице вычислять целый ряд

числовых характеристик цепи. Эти программы оказали

ПРЕДИСЛОВИЕ

7

неоценимую помощь при расчете примеров и численной

проверке теорем.

Существенное отличие нового подхода состоит еще и

в том, что отпадает нужда в использовании теории соб-

ственных значений и собственных векторов. Авторы счи-

тают, что в каждом рассматриваемом случае получен-

ные в книге матричные выражения проще, чем обычно

применяемые формулы, которые пишутся в терминах

собственных значений. Это связано, по-видимому, с тем

фактом, что фундаментальная матрица, в отличие от

собственных значений, допускает прямую вероятностную

интерпретацию.

Книга распадается на три части. Глава I представ-

ляет собой очень краткую сводку необходимых предва-

рительных сведений. В главах II—VI развивается тео-

рия цепей Маркова. Глава VII содержит приложения

этой теории к разнообразным задачам из других обла-

стей. Сводку использованных символов и основных опре-

делений и формул можно найти в добавлении. В книге

нет указателя, но нам кажется, что подробные оглав-

ление и добавление окажутся более полезными.

Вовсе не обязательно начинать чтение книги с де-

тального изучения главы I. Можно сразу же приступать

к главе II и обращаться к этому краткому введению

лишь по мере изучения последующих глав, при встрече

с незнакомыми понятиями1).

Книга написана с таким расчетом, чтобы ее можно

было использовать как материал для начального

*) Более подробное изложение большинства из этих вопросов

можно найти в любой из следующих книг: (1) М4 = Modern Mathe-

matical Methods and Models, тт. I и II, 1958 (книга составлена Дарт-

мутской группой авторов и издана Американской математической ас-

социацией) , (2) FM = К е m е п у, Snell, Thompson, Introduc-

tion to Finite Mathematics, Prentice-Hall, 1957 [русский перевод:

Дж. К e м e н и, Дж. Снелл, Дж. Томпсон, Введение в конечную

математику, «Мир», 1965. — Прим, перев}, (3) FMS = Kemeny,

Mirkil, Snell, Thompson, Finite Mathematical Structures,

Prentice-Hall, 1959. Предварительные сведения по теории вероятно-

стей, так же как изложение теории цепей Маркова с другой точки

зрения, читатель найдет в книге: W. Feller, Introduction to Proba-

bility Theory and Its Applications, Wiley, 1957 [русский перевод:

В. Феллер, Введение в теорию вероятностей и ее приложения, т. I,

«Мир», 1967. — Прим, перев.].

8

ПРЕДИСЛОВИЕ

университетского математического курса. Поэтому все

доказательства проведены на возможно более элементар-

ном уровне. Книга может служить основой полугодового

курса по теории цепей Маркова и приложениям. Выбо-

рочно ее можно использовать и в основном курсе теории

вероятностей (по нашему мнению, это относится к гла-

вам II, III, IV и частично VII). С этой же целью в конце

глав II—VI приводятся упражнения.

В книге принята следующая система обозначений:

числа обозначаются строчными латинскими буквами,

матрицы — прописными латинскими, векторы — грече-

скими. Функции, множества и прочие абстрактные объ-

екты обозначаются жирными буквами.

Авторы благодарят Национальный научный фонд за

поддержку Дартмутского математического проекта. Мно-

гие оригинальные результаты, приведенные в книге,

были получены авторами в период работы над этим

проектом. Авторы благодарны также MIT и Дартмут-

скому вычислительному центру за предоставление ма-

шинного времени, что дало возможность составить и ис-

пользовать упомянутые выше программы.

Авторы хотят поблагодарить своих научных сотруд-

ников П. Перкинса и Б. Барнса как за многие ценные

советы, так и за внимательное чтение рукописи.

Благодарим также миссис М. Эндрюс и миссис

X. Хэншетт за перепечатку рукописи.

Авторы

Гановер, Нью-Хэмпшир

сентябрь, 1959

г Л А В A I

ПРЕДВАРИТЕЛЬНЫЕ СВЕДЕНИЯ

1.1. Множества. Под множеством математик пони-

мает произвольную, но вполне определенную совокуп-

ность объектов. Объекты этой совокупности называются

элементами. Множества будут обозначаться жирными

прописными буквами.

Если дано множество А, и множество В состоит из

некоторых (не обязательно всех) элементов А, то мы

говорим, что В является подмножеством А, и обозначаем

это В А. Если два множества содержат одни и те же

элементы, то мы говорим, что эти множества равны,

А = В. Таким образом, А = В тогда и только тогда, ко-

гда А с В и В А. Если В является подмножеством

А и В не равно А, то мы говорим, что В — собственное

подмножество А, и пишем В с А. Если А и В не имеют

общих элементов, то мы называем их непер ссекающи-

мися множествами.

Очень часто мы будем иметь дело с некоторым за-

данным множеством объектов и будем рассматривать

различные его подмножества. В таком случае все это

множество мы будем называть универсальным множе-

ством U. Особый интерес среди подмножеств представ-

ляет множество, не содержащее никаких элементов, —

пустое множество Е.

Имея множество, можно разными способами из од-

них его подмножеств получать другие. Если А и В —

подмножества (/, то мы определим над ними следующие

операции.

(I) Дополнение А, А, имеет своими элементами все

элементы универсального множества, не содержащиеся

в А.

(2) Объединение А и В, A U В, имеет своими эле-

ментами все элементы А и все элементы В.

(3) Пересечение А и В, А А В, имеет своими элемен-

тами все элементы, которые принадлежат и А, и В.

10

ГЛ. I. ПРЕДВАРИТЕЛЬНЫЕ СВЕДЕНИЯ

(4) Разность А и В, А — В, имеет своими элемен-

тами все элементы А, которые не принадлежат В.

Чтобы проиллюстрировать эти операции, приведем

несколько легко доказываемых соотношений между мно-

жествами:

U = E,

1 = а,

А — В== AQB,

АЦВ = АПВ,

a7Tb = aub,

AUB = BUA,

АПВ = ВПА,

AUB = A,

Af|B = E.

Если Ai, А2, Ar— подмножества U и каждый

элемент U содержится в одном и только одном из мно-

жеств Aj, то мы говорим, что А = {Аь ..., Аг} является

разбиением множества U.

Если мы хотим задать множество, перечисляя его

элементы, то записываем эти элементы внутри фигур-

ных скобок. Например, множество пяти первых положи-

тельных целых чисел записывается как {1, 2, 3, 4, 5}.

Множество {1,3,5} является его собственным подмноже-

ством. Множество {2}, также являющееся подмноже-

ством нашего множества из пяти элементов, называется

единичным множеством, так как содержит только один

элемент.

В этой книге мы будем иметь дело как с конечными,

так и с бесконечными множествами, т. е. с множествами,

содержащими либо конечное, либо бесконечное число

элементов. Единственные бесконечные множества, кото-

рые нам будут встречаться, и притом довольно часто,—

это множество целых чисел {1, 2, 3, ...} и некоторые

его простые подмножества.

Для более детального знакомства с теорией множеств

мы отсылаем читателя к главе II FM или главе II

FMS1).

9 FM = Kemeny, Snell, Thompson, Introduction to Fi-

nite Mathematics, N. J., Prentice-Hall, Inc., 1957 [русский перевод:

Кемени, Снелл, Томпсон, Введение в конечную математику,

ИЛ, М., 1963. — Прим. ред.].

FMS = Kemen у, Mirkil, Snell, Thomson. Finite Mathe-

matical Structures, Englewood Cliffs, N. J., Prentice-Hall, Inc., 1959.

1.2. ВЫСКАЗЫВАНИЯ

И

1.2. Высказывания. Мы будем иметь дело с явле-

нием, которое чаще всего представляет собой научный

эксперимент или игру случая. У такого явления имеется

ряд различных возможных исходов. Мы будем рассмат-

ривать те или иные высказывания об этих исходах.

Образуем множество U всех логически возможных

исходов. Их нужно выбрать так, чтобы быть уверенны-

ми, что будет иметь место ровно один из этих исходов.

Множество U называется пространством возможностей.

Если р—какое-либо высказывание об исходах, то оно

будет, вообще говоря, истинно при одних возможностях

и ложно при других. Множество Р всех возможностей,

при которых р истинно, называется множеством истин-

ности высказывания р. Таким образом, каждому выска-

зыванию об исходах ставится в соответствие некоторое

подмножество множества U, а именно его множество

истинности. Выбор U для данного эксперимента не яв-

ляется единственным. Например, для двух бросаний мо-

неты можно анализировать возможности, используя

и - {НН, НТ, TH, ТТ} или U = {ОЯ, 1Я, 2Я) 1). В первом

случае указывается исход каждого бросания, во втором

только число выпавших гербов. (Более подробно эти

вопросы обсуждены в главе II FM и главе II FMS.)

Имея два высказывания р и q, относящиеся к одно-

му и тому же явлению (т. е. одному и тому же U), мы

можем различными способами формировать из них но-

вые высказывания (допустим, что эти высказывания

имеют соответственно множества истинности Р и Q):

(1) Высказывание ~р (читается «не р») истинно

тогда и только тогда, когда р ложно. Следовательно, вы-

сказывание ~р имеет множество истинности Р.

(2) Высказывание р V q (читается «р или q») ис-

тинно, если истинно либо р, либо q или истинны и р,

и q. Следовательно, высказывание р V q имеет множе-

ство истинности Р U Q.

(3) Высказывание р Aq (читается «р и <?») истинно,

если и р, и q истинны. Следовательно, высказывание

р Л q имеет множество истинности Р A Q.

9 Я ₽ head— герб, Т = tail — решетка [Прим, перев.].

12

ГЛ. I. ПРЕДВАРИТЕЛЬНЫЕ СВЕДЕНИЯ

Два частных типа высказываний принадлежат к чис-

лу основных понятий логики. Высказывание, истинное

для каждого логически возможного исхода, т. е. выска-

зывание, имеющее множество истинности 17, называется

логически истинным (такое высказывание называют ино-

гда тавтологией). Высказывание, ложное для каждого

логически возможного исхода, т. е. высказывание, имею-

щее множество истинности £, называется логически

ложным или внутренне противоречивым.

Два высказывания называются эквивалентными, ес-

ли они имеют одно и то же множество истинности. Это

означает, что одно высказывание истинно тогда и только

тогда, когда истинно другое.

Высказывания pi, р2, ..., pk являются несовместны-

ми, если пересечение их множеств истинности пусто, т. е.

если Р\ П Р2 А ... A Pk = Е. В остальных случаях эти

высказывания называются совместимыми. Если выска-

зывания несовместны, то они не могут быть все истинны.

Если высказывания совместимы, то они могут быть все

истинны.

Говорят, что высказывания образуют полное множе-

ство альтернатив, если для каждого элемента U истинно

ровно одно из этих высказываний. Это означает, что

пересечение любых двух множеств истинности пусто, а

объединение всех множеств истинности совпадает с U.

Таким образом, множества истинности полного множе-

ства альтернатив образуют разбиение U. Полное мно-

жество альтернатив представляет новый (вообще говоря,

менее подробный) способ анализа возможных исходов.

1.3. Отношения порядка. Нам понадобятся некото-

рые простые сведения из теории отношений порядка.

Полное изложение этих вопросов можно найти в М4,

т. II, часть 21), откуда мы заимствуем лишь отдельные

понятия.

Пусть R — какое-то отношение между двумя объекта-

ми (выбранными из данного множества U). Запись aRb

означает, что а находится в отношении R к Ь. Нас будут

интересовать следующие свойства таких отношений:

!) м4 = Modern Mathematical Methods and Models, Mathemati-

cal Association of America, 1958 (Дартмутская группа авюров).

1.3. ОТНОШЕНИЯ ПОРЯДКА

13

1.3.1. Определение. Отношение R называется рефлек-

сивным, если xRx выполняется для всех х из U.

1.3.2. Определение. Отношение R называется симмет-

ричным, если для любых х, у из U из выполнения xRy

вытекает yRx.

1.3.3. Определение. Отоношение £ называется тран-

зитивным, если для любых х, у, г из U из xRy A yRz

вытекает xRz.

1.3.4. Определение. Всякое рефлексивное, симметрич-

ное и транзитивное отношение называется отношением

эквивалентности.

Основное свойство отношения эквивалентности состо-

ит в том, что оно задает разбиение множества U. Имен-

но, пусть R — отношение эквивалентности, определенное

на U. Разобьем элементы U на классы, относя два эле-

мента а и Ь к одному классу, если aRb. Можно показать,

что получатся вполне определенные взаимно исключаю-

щие классы, образующие разбиение множества U. Они

называются классами эквивалентности отношения R.

Например, пусть xRy означает, что х имеет тот же

рост, что и у, где U — некоторое множество людей. Тогда

определенное выше разбиение делит этих людей по при-

знаку роста. Два человека окажутся в одном и том же

классе эквивалентности тогда и только тогда, когда они

одного роста.

1.3.5. Определение. Отношение Т называется совме-

стимым с отношением эквивалентности R, если при xRy

из xTz следует yTz и из zTx следует zTy.

1.3.6. Определение. Рефлексивное транзитивное отно-

шение называется отношением слабого упорядочения.

Отношение слабого упорядочения можно использо-

вать для упорядочения элементов множества U. При

слабом упорядочении Т для любых двух элементов а

и b из U существуют четыре возможности:

(1) аТЬ А ЬТа, тогда эти два элемента «подобны»

в смысле Т;

(2) аТЬ А ~ ЬТа, тогда а «предшествует» &;

(3) ~ аТЬ А ЬТа, тогда Ь «предшествует» а;

(4) ~аТЬ А ~ ЬТа, тогда эти два элемента несрав-

нимы.

14

ГЛ. I. ПРЕДВАРИТЕЛЬНЫЕ СВЕДЕНИЯ

Например, если хТу означает, что «я люблю х по

крайней мере так же, как и у», то такими четырьмя слу-

чаями будут: «Я люблю их одинаково», «Я предпочи-

таю х», «Я предпочитаю у» и «Я не могу сделать выбор

между ними».

Это отношение «подобия» действует как отношение

эквивалентности. В самом деле, можно показать, что

если Т — слабое упорядочение, то отношение xRy, выра-

жающее, что хТу Л уТх, является отношением эквива-

лентности, совместимым с Т, Таким образом, Т служит

и для классификации, и для упорядочения. Совмести-

мость гарантирует нам, что эквивалентные элементы I)

будут занимать одинаковые места при таком упорядо-

чении.

Например, если задать слабое упорядочение усло-

вием «не ниже», то это условие определит отношение

эквивалентности «одного и того же роста», совместимое

с первоначальным отношением.

1.3.7. Определение. Если Т — слабое упорядочение,

то порожденным им отношением эквивалентности назы-

вается отношение хТу А уТх.

1.3.8. Определение. Если Т — слабое упорядочение и

порожденное им отношение эквивалентности является

отношением тождества (х ~ У) , то Т называется частич-

ным упорядочением.

Сущность частичного упорядочения в том, что ника-

кие два различных элемента не являются при нем по-

добными. Один из способов частичного упорядочения

состоит в следующем. Пусть Т — слабое упорядочение,

определенное на U, Определим новое отношение Т*

на множестве классов эквивалентности, полагая uT*v,

если каждый элемент из и находится в отношении Т

к каждому элементу из v. Это частичное упорядочение

классов эквивалентности мы будем называть частичным

упорядочением, индуцированным Т.

1.3.9. Определение. Элемент а множества U назы-

вается минимальным, если из аТх следует хТа для лю-

бого х <=U. Если минимальный элемент является един-

ственным, то его называют минимумом.

Можно аналогичным образом определить «макси-

мальный элемент» и «максимум». Если U — конечное

1.4. ОТНОШЕНИЯ СВЯЗИ

15

множество, то легко показать, что для любого слабого

упорядочения существует по меньшей мере один мини-

мальный элемент. Однако этот минимальный элемент не

обязательно единственный. Аналогично, для слабого упо-

рядочения должен существовать максимальный элемент,

но не обязательно максимум.

1.4. Отношения связи. Отношения порядка находят

важное применение при изучении коммуникационных

сетей. Предположим, что г лиц связаны посредством

сложной сети. Каждое лицо может послать сообщение

некоторому подмножеству лиц. Это мы называем пря-

мой связью. Сообщения могут передаваться и в несколь-

ко этапов ретрансляцией. Это уже будет непрямая связь.

Заметим, что мы не предполагаем, что любое лицо имеет

прямую связь с самим собой. Пусть аТЬ означает, что а

имеет (прямую или непрямую) связь с b или что а = Ь.

Легко установить, что Т задает слабое упорядочение

рассматриваемого множества лиц. Это упорядочение по-

рождает отношение эквивалентности хТу А уТх, которое

читается как «х и у могут сообщаться друг с другом или

X = у».

Это отношение эквивалентности можно использовать

для классификации рассматриваемых лиц. Два лица

окажутся тогда в одном и том же классе эквивалентно-

сти, если они сообщаются друг с другом, т. е. если каж-

дый из них имеет связь с другим. Частичное упорядоче-

ние Т*, индуцированное Т, в данном случае имеет очень

простой смысл. Отношение uT*v выполняется, если все

представители класса и имеют связь со всеми представи-

телями класса V, но не наоборот (за исключением слу-

чая и — v). Таким образом, частичное упорядочение ука-

зывает на возможное направление передачи информации.

В частности, класс и является максимальным эле-

ментом частичного упорядочения, если представители

любого другого класса не имеют связи с представите-

лями и,н и является минимальным элементом, если его

представители не имеют связи с представителями дру-

гих классов. Таким образом, максимальные множества

являются источниками сообщений, а минимальные — их

конечными приемниками (см. М4, т. II, часть 2).

16

ГЛ. I. ПРЕДВАРИТЕЛЬНЫЕ СВЕДЕНИЯ

Рассмотрим подробнее некоторый класс эквивалент-

ности. Любые два элемента такого класса имеют связь

друг с другом. Поэтому любой элемент может передать

сообщение любому другому элементу. Возникает вопрос,

сколько времени требуется для такой передачи. За еди-

ницу времени примем время, необходимое для передачи

сообщения от любого элемента к любому другому эле-

менту при прямой связи. Эту единицу назовем шагом.

Предположим, что сообщение посылает элемент i, и за-

дадимся вопросом, где может оказаться это сообщение

через п шагов.

Пусть Nij — множество таких п, что сообщение, исхо-

дящее от /, может оказаться у / на n-м шаге. Вначале

рассмотрим Na, т. е. множество тех моментов времени,

за которые сообщение может вернуться к своему источ-

нику. Ясно, что если а е Na и & е Na, то а + b е Na,

так как сообщение может возвратиться через а шагов,

может быть снова послано и снова принято обратно еще

через b шагов. Таким образом, множество Na инва-

риантно относительно сложения. Нам понадобится сле-

дующий результат из теории чисел, доказательство ко-

торого приводится в конце этого пункта.

1.4.1. Теорема. Множество положительных целых чи-

сел, инвариантное относительно сложения, содержит все

целые кратные наибольшего общего делителя этих чисел,

за исключением быть может конечного числа таких

кратных.

Если наибольший общий делитель элементов Na ра-

вен di, то ясно, что все элементы Na делятся на di. Тео-

рема 1.4.1, сверх того, утверждает, что все достаточно

большие числа, кратные di, являются элементами этого

множества.

Так как каждый элемент имеет связь с каждым эле-

ментОхМ в своем классе эквивалентности, то множества

не пусты. Докажем теперь, что для in j, принадле-

жащих одному и тому же классу эквивалентности,

dt = dj = d и что числа данного множества N^ срав-

нимы друг с другом по модулю d (их разность де-

лится на d). Предположим, что а е Nij, b е Nij и

с Nji.

1.4. ОТНОШЕНИЯ СВЯЗИ

17

Прежде всего элемент i имеет связь с самим собой,

так как он может послать сообщение элементу / и за-

тем получить его обратно. Поэтому а + с е Na. С другой

стороны, сообщение может быть послано элементу /,

вернуться к нему снова, а затем передано элементу i.

Такая передача может быть осуществлена за a + kdj + c

шагов при любом достаточно большом k. Отсюда сле-

дует, что dj должно делиться на di. Но точно тем же

способом можно доказать, что di делится на dj, и по-

этому dj== di d.

Далее, сообщение может быть передано от i к / за

b шагов, а затем возвращено к I. Поэтому b + с е Na.

Значит, а + с и b + с оба делятся на d, и, таким обра-

зом, a^&(modd). Итак, все числа из множества

сравнимы друг с другом по модулю d. Поэтому можно

ввести такие числа Uj, 0 t^ < d, что любой элемент из

Nij сравним с по модулю d. Легко также убедиться,

что множество содержит все числа вида tij + kd за

конечным числом исключений.

В частности, видно, что в любом случае tn = 0, и по-

тому tij + tji = 0 (mod d). Кроме того, t^ + tjm =

= tim(modd). Отсюда легко усмотреть, что tij = 0 пред-

ставляет собой отношение эквивалентности. Назовем

соответствующий класс эквивалентности циклическим

классом.

Так как tij + tjm=tim(modd), то t^ = tim тогда и

только тогда, когда tjm = 0, а потому необходимым и

достаточным условием равенства tij = tim является

принадлежность элементов / и т к одному цикличе-

скому классу. Пусть п — любое целое число. Если

rc = ^(mod d), то сообщение, исходящее от i, через п

шагов может находиться только в соответствующем цик-

лическом классе. Отсюда сразу следует, что имеется

ровно d циклических классов и что сообщение передает-

ся циклически из класса в класс с периодом d. Легко

также показать, что по прошествии достаточно боль-

шого промежутка времени сообщение может оказаться

у любого представителя циклического класса, соответ-

ствующего данному п.

Приведенное описание класса эквивалентности ком-

муникационной сети справедливо во всех случаях, только

% Дж. Кемени, Дж. Снелл

18

ГЛ. I. ПРЕДВАРИТЕЛЬНЫЕ СВЕДЕНИЯ

при d == 1 цикл вырождается. В этом случае имеется

единственный «циклический класс», и по прошествии

достаточно большого отрезка времени сообщение может

оказаться в любой момент у любого элемента.

В частности, следует отметить, что если какой-нибудь

один элемент класса эквивалентности имеет прямую

связь с самим собой, то d = 1. Это сразу следует из того

факта, что d является делителем любого отрезка вре-

мени, за которое элемент может установить связь с са-

мим собой, и поэтому 1 должна делиться на d.

Приведенный под номером 1.4.1 результат из теория

чисел настолько важен, что мы дадим здесь его доказа-

тельство.

Прежде всего заметим, что если наибольший общий

делитель d элементов множества не равен 1, то все их

можно поделить на d и свести дело к случаю d = 1, ко-

торый мы и рассмотрим. Если имеется множество чисел

с наибольшим общим делителем, равным 1, то этим

Свойством обладает и некоторое конечное его подмноже-

ство. Поэтому, на основании хорошо известного резуль-

тата, существует линейная комбинация ахп\ + а2п2 + ...

... A-ahnh элементов множества (с положительными или

отрицательными целыми коэффициентами аг), которая

равна 1. Если мы сгруппируем все положительные и

все отрицательные члены отдельно и вспомним, что

наше множество инвариантно относительно сложения, то

получим, что этому множеству принадлежат такие чис-

ла т и п, что т — п = 1 (т является суммой положи-

тельных, а п — суммой отрицательных членов). Пусть

q — любое достаточно большое число, или, точнее,

q^n(n—1). Тогда можно написать, что q = ап 4- &,

где —1 и —1. Но в таком случае

q = (а — Ь)п + Ьт, и потому q принадлежит нашему мно-

жеству.

1.5. Вероятностные меры. При вероятностном ана-

лизе эксперимента имеется два основных этапа. Вначале

выбирается множество логических возможностей. Этот

вопрос обсуждался в 1.2. Затем вводится вероятностная

мера. Способы ее введения рассматриваются в этом

пункте. Обратимся сперва к случаю конечного простран-

1.5. ВЕРОЯТНОСТНЫЕ МЕРЫ

19

ства возможностей. (Для более подробного ознакомле-

ния с этими вопросами отсылаем читателя к FM, гла-

ве IV, или к FMS, главе III.)

1.5.1. Определение. Пусть U = {аь аг} — некото-

рое множество логических возможностей. Вероятностная

мера на U вводится путем приписывания каждому эле-

менту aj положительного числа называемого ве-

сом, так, чтобы эти веса давали в сумме 1. Мера под-

множества А множества U, обозначаемая через т(А),

полагается равной сумме весов, приписанных элементам

подмножества А.

1.5.2. Теорема. Вероятностная мера т, введенная на

множестве логических возможностей U, обладает сле-

дующими свойствами'.

(1) Для любого подмножества Р из U O^m(P)^ 1.

(2) Если Р и Q — непер ссекающие с я подмножества

U, то m(P U Q) = m(P) + m(Q).

(3) Для любых подмножеств Р и Q множества U

m(P U Q) = т(Р) + m(Q) —т(Р Г) Q).

(4) Для любого множества Р из U т(Р) = 1 —т(Р).

1.5.3. Определение. Пусть р — высказывание относи-

тельно множества U с множеством истинности Р. Тогда

вероятность р при данной вероятностной мере m пола-

гается равной т(Р) {и обозначается Р[р]).

В любом случае, когда вероятностная мера фиксиро-

вана, мы будем просто говорить о вероятности р, не упо-

миная каждый раз эту меру. Из теоремы 1.5.2 и связи

между операциями над высказываниями и операциями

над множествами вытекает следующий результат:

1.5.4. Теорема. Пусть U — множество возможностей,

на котором определена вероятностная мера. Тогда ве-

роятности высказываний, задаваемые этой мерой, обла-

дают следующими свойствами:

(1) Для любого высказывания р 0^Р[р]<С1.

(2) Если р и q несовместны, то Р [р V q] = Р [р] +

+ РМ,

(3) Для любых двух высказываний pug

Р Ь V - Р [р] + Р fa] - Р [р А д].

(4) Для любого высказывания р Р[~р] = 1 — Р[р].

2‘

20

ГЛ. I. ПРЕДВАРИТЕЛЬНЫЕ СВЕДЕНИЯ

1.5.5. Пример. На любом конечном множестве из s

элементов можно определить вероятностную меру, при-

писав каждому элементу вес 1/5. Такая мера называется

равновероятной. Для любого множества А, состоя-

щего из г элементов, m(A) = r/s. Например, такую меру

обычно используют, рассматривая бросание игральной

кости. В этом случае U = {1, 2, 3, 4, 5, 6} и каждому ис-

ходу приписывают вес 11в.

1.5.6. Пример. В качестве другого примера, когда на-

значаются различные веса, рассмотрим игру на скачках.

Игрок, делающий ставку, сравнивает лошадей а, b и с

и приходит к заключению, что лошади а п b имеют оди-

наковый шанс выиграть, тогда как шансы на выигрыш

у лошади с в два раза больше, нежели у а. Множество

логических возможностей в этом случае имеет вид

U = {а, &, с}, а его элементам назначаются веса w(a) =

= ’/4, W (&) = J/4 И W(c) = V2.

Часто требуется обобщение приведенных выше поня-

тий на случай, когда эксперимент имеет бесконечную по-

следовательность возможных исходов. Например, рас-

смотрим опыт, состоящий в бросании монеты до тех пор,

пока она впервые не упадет гербом вверх. Множеством

возможных исходов в этом случае будет С/ = {1, 2, 3,...}.

Приведенные выше определения и теоремы будут в рав-

ной степени применимы и к этому множеству возможных

исходов. Мы будем иметь теперь бесконечное число ве-

сов, но по-прежнему их сумма должна быть равна 1.

В данном случае следует назначить веса 7г, 74, 7в, ...»

которые, образуя геометрическую прогрессию, дают в

сумме 1.

1.6. Условная вероятность. Часто бывает, что вероят-

ностная мера уже введена на некотором множестве 17,

а затем выясняется, что относительно U справедливо не-

которое высказывание q. Располагая этой новой инфор-

мацией, мы переходим от прежнего множества возмож-

ностей к новому множеству возможностей, совпадающе-

му с множеством истинности Q высказывания q. На ос-

нове первоначальной меры т мы хотим определить ве-

роятностную меру на этом новом множестве. Мы делаем

это, требуя, чтобы элементы Q имели те же самые отно-

1.6. УСЛОВНАЯ ВЕРОЯТНОСТЬ

21

сительные веса, что и первоначально. Это означает, что

наши новые веса должны быть равны старым, умно-

женным на некоторую константу так, чтобы в сумме

снова получилась I. Константа будет равна обратной

величине суммы весов всех элементов в Q, т. е. I/m(Q).

(См. главу IV FM или главу III FMS.)

1.6.1. Определение. Пусть U = {аь ..., аг} — множе-

ство возможностей, на котором введена мера с помощью

весов w(aj). Пусть q — высказывание относительно мно-

жества U, не являющееся внутренне противоречивым.

Тогда условной вероятностной мерой при условии q на-

зывается вероятностная мера на множестве истинности

Q высказывания q, задаваемая весами

1.6.2. Определение. Пусть р и q — два высказывания

относительно множества U (и q не внутренне противоре

чиво). Условной вероятностью р при условии q, обозна-

чаемой Р [р | q], называется вероятность высказывания р,

вычисленная по условной вероятностной мере при усло-

вии q.

1.6.3. Теорема. Пусть р и q — два высказывания от-

носительно U (и q не внутренне противоречиво). Пред-

положим, что на множестве U определена вероятностная

мера m Тогда

Р[р|?1-Т^,

где Р[р A q] и Р[<?] определяются с помощью меры ш.

1.6.4. Пример. Допустим, что игрок на скачках из

примера 1.5.6 узнает, что лошадь b не будет выступать.

Это вынуждает его рассмотреть новое пространство воз-

можностей Q = {а, с}. Новые веса, определяющие услов-

ную меру, равны w (а) = = 7з и w (с) = =

= 2/3. По-прежнему вероятность выигрыша лошади с в

два раза больше вероятности выигрыша лошади а,

1.6.5. Определение. Два высказывания р и q (из ко-

торых ни одно не является внутренне противоречивым),

называются независимыми, если Р[рА<?]= Р[р]РМ.

22

ГЛ. I. ПРЕДВАРИТЕЛЬНЫЕ СВЕДЕНИЯ

Из теоремы 1.6.3 следует, что р и q независимы то-

гда и только тогда, когда P[pld=P[p] иРк1р]=Р[?].

Таким образом, независимость высказываний р и q озна-

чает, что известие об истинности одного высказывания

не влияет на вероятность, приписываемую другому.

1.6.6. Пример. Рассмотрим испытание, состоящее в

двукратном бросании монеты. Исходы испытаний состав-

ляют множество и = {НН, НТ, TH, ТТ}. Введем равно-

вероятную меру. Пусть р означает, что герб выпадает

при первом, a q — при втором бросании монеты. Тогда

Р[РА<7] = 74. Р[Р1 = РЫ = 72. Таким образом, р и q не-

зависимы.

1.7. Функции на пространстве возможностей. Пусть

U = {аь ..., а,} — пространство возможностей и f — не-

которая функция с областью определения U и областью

значений R = {ri,r2, ..., г}- Это значит, что f сопостав-

ляет каждому элементу U единственный элемент из R.

Если f сопоставляет элементу dj элемент rki то мы пи-

шем f(dj)~ Гк- Высказывание «значение функции равно

Г/.» записывается в виде f = Это высказывание яв-

ляется высказыванием относительно множества 17, так

как значение функции известно, когда известен исход

dj. Значит, это высказывание имеет множество истинно-

сти, являющееся подмножеством U. (См. главы II и III

FMS или М4, т. II, разд. I.)

1.7.1. Определение. Пусть f — функция с областью

определения U и областью значений R. Предположим,

что на множестве U задана мера. Для каждого rk из R

положим w(rk)= = Веса w(rk) определяют ве-

роятностную меру на множестве R, которая называется

мерой, индуцированной функцией f. Веса w(rk) назы-

ваются индуцированными весами.

Индуцированную меру мы будем обычно задавать,

указывая одновременно область значений и веса в виде

следующей таблицы:

е. f г2, .rs 1

' ' I Ни), w(r2), • w(rs)/’

Таким образом, индуцированный вес rh в R является

мерой множества истинности высказывания f г> в U.

1.7. ФУНКЦИИ НА ПРОСТРАНСТВЕ ВОЗМОЖНОСТЕЙ

23

1.7.2. Пример. Пусть в примере 1.6.6 функция f озна-

чает число выпавших гербов. Областью • значений f

является/? = {О, 1, 2}. Очевидно, P{f = 0} = '/4. Ptf = U=

= 72 и Р0 = 2} = 'Л. Значит, область значений и инду-

цированные веса задаются таблицей

О

4

1

72

2

74

1.7.3. Определение. Пусть U — пространство возмож-

ностей .и f и g— две функции с областью определения

U и областями значений, являющимися числовыми мно-

жествами. Тогда f+g обозначает функцию с областью

определения U, сопоставляющую элементу число

+ a f'g — функцию с областью определения

U, сопоставляющую элементу число f (а^) • g (aj). Для

любого числа с постоянной функцией с является функ-

ция, сопоставляющая число с любому элементу из U.

Пусть U — пространство возможностей, на котором

задана мера. Если f и g — две числовые функции с обла-

стью определения U, то f + g и f • g также будут функ-

циями с областью определения U, и как таковые они

индуцируют некоторые меры. Вообще говоря, не суще-

ствует простой связи между мерами, индуцированными

этими функциями, и мерами, индуцированными f и g.

1.7.4. Пример. Вернемся к примеру 1.6.6. Пусть

функция g принимает значение 1, если при первом бро-

сании выпал герб, и 0 — в противном случае. Функция h

принимает значение I, если герб выпал при втором бро-

сании, а 0 — если выпала решетка. Тогда области зна-

чений и индуцированные меры для g, h, g + h и g • h

можно представить в виде

Г ° В . ( О 11

fT/2 72Г i72 7J’

£ + А:{ °

I /4

V /4

1 2

7г 74

1 I

74Г

24

ГЛ. I. ПРЕДВАРИТЕЛЬНЫЕ СВЕДЕНИЯ

1.7.5. Определение. Пусть f — функция, определенная

на U, и пусть р — высказывание относительно U с мно-

жеством истинности Р. Предположим, что на U задана

мера т. Пусть f' — функция f, рассматриваемая только

на множестве Р. Тогда мера, индуцированная f и вы-

численная по условной мере при условии р, называется

условной мерой, индуцированной f при условии р.

1.7.6. Определение. Пусть f и g—две функции, опре-

деленные на пространстве U, на котором задана вероят-

ностная мера. Тогда fug называются независимыми,

если для любого rh из области значений f и любого sf

из области значений g высказывания f = rh и g = Sj не-

зависимы.

Эквивалентное определение независимости двух функ-

ций получится, если сказать, что мера, индуцированная

одной из функций, не меняется, когда становится из-

вестным значение другой функции.

1.8. Среднее значение и дисперсия функции. В этом

параграфе мы будем рассматривать функции, области

значений которых — числовые множества. Подробное об-

суждение понятий, вводимых в данном параграфе, см.

в FMS, глава III, или М4, т. II, разд. I.

1.8.1. Определение. Пусть f — функция, определенная

на пространстве возможностей U = {а\, а%, ..., ап}, на

котором с помощью весов w(aj) задана мера. Тогда

средним значением f (обозначается М [fl) называется ве-

личина

Вместо термина среднее значение часто используется

термин математическое ожидание.

1.8.2. Теорема. Пусть f—функция, определенная на

U. Предположим, что на U задана вероятностная мера

m и что функция f индуцирует меру

T'[w(ri), w(r2), ..w(rn) Г

Тогда

М1Л = 2 r/w(rz).

1.8. СРЕДНЕЕ ЗНАЧЕНИЕ И ДИСПЕРСИЯ ФУНКЦИИ

25

1.8.3. Пример. Пусть в условиях примера 1.6.6 функ-

ция f —это число выпавших гербов. По определению

среднего значения

М[Л = f (НН) • 74 + f (НТ) • >/4 + f (тн) • */4 + f (ТТ) • 74 =

= 2-74+1 • 74+1 • 74 + о-74= +

Среднее значение f можно также вычислить, воспользо-

вавшись теоремой 1.8.2. Область значений и мера, инду-

цированные f, задаются в виде

1 О 1 21

Г 1 74 72 74)’

По теореме 1.8.2

М[Л = о-74 +1 • 72 + 2 - 74= 1.

1.8.4. Определение. Пусть f — функция, определенная

на пространстве возможностей U, на котором задана

мера, и пусть M[fl = m— среднее значение этой функ-

ции. Тогда дисперсией f (обозначается D[fl) называется

среднее значение функции (f — m) 2. Стандартным откло-

нением (обозначается o[f]) называется квадратный ко-

рень из дисперсии,

1.8.5. Теорема. Пусть f — функция со средним зна-

чением т. Тогда D [Л = М [f2] — пг2.

1.8.6. Пример. Пусть / — функция из примера 1.8.3.

Мы нашли, что М[/]=1. Таким образом,

D [Л = (2 -1)2 • 74 + (1 -1)2 • 74 + (О — 1)2 • 74 = 72.

Другой метод подсчета дисперсии состоит в использо-

вании теоремы 1.8.5. Находим

М[Л] = 4.74+ 1-74+о-74 = 72.

Так как М [Л = 1, то D [Л = 72 ~ 1 = 72-

1.8.7. Теорема. Пусть f и g — любые две функции,

для которых определены средние значения и дисперсии.

Тогда

(1)М[с] = с. (4) DWWDtf].

(2) М[/ + £] = М[Л + М[£]. (5) D[<? + fl»D[fl.

(3) М [сЛ = сМ [Л- (6) D [с] = 0.

26

ГЛ. 1. ПРЕДВАРИТЕЛЬНЫЕ СВЕДЕНИЯ

Если функции fug независимы, то

(7) М[^ЬМ[ЛМИ.

(8) D [f + g] = D [f] + D[g].

1.8.8. Определение. Пусть р — некоторое высказыва-

ние относительно множества возможностей U, на кото-

ром задана мера, и пусть f — функция с областью опре-

деления U. Условным средним значением и условной

дисперсией f при условии р называются среднее значе-

ние и дисперсия f, вычисленные по условной мере при

условии р. Мы обозначаем их М[/|р] и D [/ |р].

1.8.9. Теорема. Пусть рь р2, рг — полное множе-

ство альтернатив для множества U и f — функция с об-

ластью определения U. Тогда

м[л = 5м[/|р/]Р[р/.

1.8.10. Теорема. Пусть /ь /г, • • • — последовательность

функций такая, что для некоторой постоянной с

при п-^ со. Тогда

М [/„]-> с

и для любого 8>0

Р[

При П~> ОО

1.8.11. Определение. Пусть fx и f2 — dee функции,

причем M[fi] = ai и = Тогда ковариация fx и

определяется формулой

К [А, М = М [(А

а коэффициент корреляции f{ и f2 — формулой

1.9. Стохастические процессы. В этом пункте мы

вкратце опишем понятие стохастического процесса. Бо-

лее полное изложение можно найти в главе IV FM или

в главе III FMS.

1.9. СТОХАСТИЧЕСКИЕ ПРОЦЕССЫ

27

Мы хотим задать вероятностную меру, которая опи-

сывала бы эксперимент, происходящий в несколько эта-

пов. Исход и-го этапа может зависеть от исходов

предыдущих этапов. Предполагается однако, что вероят-

ность каждого возможного исхода на определеннохм

этапе известна, если заданы исходы всех предыдущих

этапов. Зная эти вероятности, мы можем построить про-

странство возможностей и меру для всего эксперимента.

Мы проиллюстрируем построение пространства воз-

можностей и меры на частном примере, из которого бу-

дет ясна общая процедура.

1.9.1. Пример. Случайно выбирается одна из двух

монет А или В. Монета А — настоящая, а на монете В

с обеих сторон изображен герб. Выбранная монета под-

брасывается. Если выпала решетка, то бросают кость.

Если выпал герб, монету подбрасывают снова. Первый

этап эксперимента — выбор монеты. На втором этапе

бросают монету. На третьем этапе бросают кость или

монету, в зависимости от исходов первых двух этапов.

Возможные исходы эксперимента мы изображаем в

виде дерева, как это показано на рис. 1.1.

28

ГЛ. I. ПРЕДВАРИТЕЛЬНЫЕ СВЕДЕНИЯ

Возможны следующие исходы: t\ = (A, Н, Я), 12 =

-(А, Я, Т), /3 = (А, Т, 1), /4 = (А, Т, 2) и т. д. Каждый

исход отождествляется с некоторым путем на дереве.

Всякий путь состоит из прямолинейных отрезков, назы-

ваемых ветвями. На только что определенном дереве

имеется девять путей, каждый из которых состоит из

трех ветвей.

Мы знаем вероятности каждого исхода на данном

этапе, если известны исходы предыдущих этапов. На-

пример, если на первом этапе появилось А, а на втором

Т, то вероятность появления 1 на третьем этапе равна

Ve. Мы припишем эти известные вероятности ветвям и

назовем их вероятностями ветвей.

Определим теперь вес каждого пути как произведе-

ние вероятностей, приписанных образующим этот путь

ветвям. Например, путь /7 соответствует исходу А на

первом этапе, Т — на втором и 5 на третьем. Вес, при-

писанный этому пути, равен V2 • V2 • 1/б = 1/г4. Описанная

процедура задает вес каждого пути на дереве, причем

сумма всех весов равна 1. Множество U всех путей го-

дится в качестве пространства возможностей при рас-

смотрении любого высказывания, истинность которого

зависит от исходов всего эксперимента. Мера, заданная

весами путей, является при этом соответствующей ве-

роятностной мерой.

Описанное построение можно проделать для любого

эксперимента, происходящего по этапам. Требуется

только, чтобы на каждом этапе было конечное число

возможных исходов и чтобы нам была известна вероят-

ность'каждого отдельного исхода на j-м этапе при за-

данных исходах первых (/—1) этапов. Так для любого

/ получается дерево Uj. Множество путей этого дерева

служит пространством возможностей для любого выска-

зывания, связанного с первыми / этапами. Зададим меру

на множестве всех путей дерева Uj, во-первых, опреде-

лив вероятности ветвей, а затем положив вес, приписы-

ваемый какому-то пути, равным произведению вероятно*

стей всех его ветвей. Меры, заданные на каждом дереве,

согласованы между собой в следующем смысле. Выска-

зывание, истинность которого зависит лишь от первых

j этапов, можно, конечно, рассматривать как высказы-

1.9. СТОХАСТИЧЕСКИЕ ПРОЦЕССЫ

29

вание относительно любого дерева С7г- при i j. На каж-

дом из этих деревьев задана его собственная мера, и

вероятность высказывания можно найти по любой из

этих мер. Но в любом случае получится одна и та же

вероятность.

Предположим, что задано дерево некоторого экспе-

римента, состоящего из п этапов. Пусть ft —функция,

область определения которой — множество путей Un, а

значение — исход /-го этапа. Функции fi, ..., fn назы-

ваются функциями исходов. Множество функций ...

.fn называется стохастическим процессом. (В тео-

рии цепей Маркова удобно обозначить первый исход не

f„ а М

В нашем примере имеется три функции исходов. Мы

представили на рис. 1.1 значения каждой функции на

каждом из путей.

Между вероятностями ветвей и функциями исходов

имеется простая связь. Вероятности ветвей на первом

этапе — это вероятности

Р[А = пЬ

на втором этапе — это

P[f2 = r/|f1 = rz],

на третьем этапе —

P[f3 = rft = =гг]

И Т. д.

В нашем примере

р [А = 4] = №(#])+ ... +w(#8) = ’/2>

р [А = т If, = А] = =

_ «>«з)+ +«>(*8) I/.

w(h)+ ... +w(z8) >/2 /2>

Р [f, = 1 I f _ у д f _ я 1 _ Р Уз = 1ЛЬ = ГЛЬ = А]

1/з ИГ2 /ЛП-AJ- Ptf2 = rAfi=A] -

________w(/3)______= У24 _

®(*з)+ ••• +w(#8) Уз '6‘

1.9.2. Пример. Нам часто придется иметь дело с экс-

периментами, в которых допускается произвольное число

30

ГЛ. I. ПРЕДВАРИТЕЛЬНЫЕ СВЕДЕНИЯ

этапов. Например, рассматривая бросания монеты, мы

можем наблюдать любое число бросаний. Для случая

трех бросаний на рис. 1.2 представлены дерево и вероят-

ности путей.

Дерево можно сконструировать для любого количе-

ства бросаний. Достраивая дерево неограниченно дале-

ко, можно даже получить дерево с бесконечными пу-

тями. Наш метод построения меры в этом случае не

wftj

%

’/в

'/в

%

’/в

’/в

%

'/8

пригоден, так как он относит каждому пути меру 0. Нам

не придется, однако, задавать меру на бесконечном де-

реве. Дело в том, что интересующие нас высказывания

о процессе будут зависеть только от конечной части де-

рева, а для любого конечного числа этапов метод по-

строения меры уже имеется. Тем не менее мы будем

иногда рассматривать функции, в определении которых

участвует бесконечное дерево.

Пусть, скажем, в примере 1.9.2 функция f— это но-

мер бросания, при котором впервые появляется герб. То-

гда / определена для всех путей, на которых хотя бы

раз встречается герб. Эти пути образуют подмножество

бесконечного дерева. Мы будем говорить о среднем зна-

чении подобной функции, если выполнены следующие

условия:

1.9. СТОХАСТИЧЕСКИЕ ПРОЦЕССЫ

31

а) Найдется такая последовательность чисел

Гь Гг, • • • ’ чт0 истинность высказывания f == г, зависит

только от исходов конечного числа этапов и 2P[f = r/] = l.

Ь) 5 |Г/|Р[/ = Г/]<оо.

В случае выполнения условий а) и Ь) мы говорим, что

f имеет среднее значение, и определяем его формулой

м [Л =2 Г/Р [Г = Г/].

/

Если f имеет среднее значение а и определено сред-

нее значение для (f — а)2, то мы говорим, что функция f

имеет дисперсию D [fl, равную M[(f — а)2].

Все свойства средних и дисперсий, сформулирован-

ные в § 8, выполняются и в этом более общем случае.

Кроме того, нам потребуется следующая теорема.

1.9.3. Теорема1). Если fl,f2, ... — такие функции, что

область значений каждой fj есть подмножество одного и

того же конечного множества чисел, и если функция

s = fi + fz + ... имеет среднее значение, то

МЫ=2М[/;].

Назовем конечным стохастическим процессом такой

стохастический процесс, все функции исходов которого

принимают значения из данного конечного множества.

!) В такой форме, как показывают несложные примеры, тео-

рема не верна. Однако для последующих нужд вполне достаточно

более слабого утверждения:

Теорема. 1.9.3'. Если fi, fz, ... — такие функции, что их области

значений принадлежат одному и тому же конечному множеству не-

отрицательных чисел, и если s = + ... -ь fn + ..., причем М [$] су-

ществует, то

/

Это утверждение является очень частным случаем известной

теоремы Лебега о монотонном предельном переходе. Впрочем, его

можно доказать и элементарно, пользуясь тем, что абсолютно схо-

дящийся ряд допускает перестановку и группировку членов. (Прим,

перев.)

32

ГЛ. I. ПРЕДВАРИТЕЛЬНЫЕ СВЕДЕНИЯ

Тогда теорема 1.9.3 устанавливает, что в конечном сто-

хастическом процессе среднее суммы функций (если оно

существует) равно сумме средних значений этих функ-

ций.

1.10 Суммируемость последовательностей и рядов.

Бывает, что по расходящейся последовательности

So, si, ..., sn, ... можно построить такую последова-

тельность средних из что эта новая последователь-

ность сходится. В таком случае мы говорим, что исход-

ная последовательность суммируема с помощью данного

процесса осреднения. Мы будем иметь дело только с

двумя методами осреднения,

ft-l п

Пусть /„ = '/„]£ s‘ и w»= S

1=0 1=0

при некотором k из промежутка 0<6<1. Каждое из

этих выражений есть среднее членов последовательно-

сти Si с неотрицательными коэффициентами, сумма ко-

торых равна 1. Если последовательность /2, ... схо-

дится к пределу t, то мы говорим, что исходная после-

довательность суммируема по Чезаро к t. Если после-

довательность Ui, «2, ... сходится к пределу и, то мы

говорим, что исходная последовательность суммируема

по Эйлеру к и.

Рассмотрим, например, последовательность 1, 0, 1,

0, ... Легко видеть, что tn = V2, если п четно, и

tn = V2 + 7п, если п > 1 нечетно. Эта последователь-

ность сходится к V2 и, значит, исходная последователь-

ность суммируема по Чезаро к V2. Нетрудно проверить,

что limwrt = 1/2, и> следовательно, исходная последова-

->оо

тельность суммируема к У2 и по Эйлеру. Начальная же

последовательность расходится.

Нам потребуются два следующих простых факта от-

носительно суммируемости: (1) Если последователь-

ность сходится, то она суммируема каждым из указан-

ных методов к своему пределу. (2) Если последователь-

ность суммируема обоими методами, то обе суммы

должны совпадать.

1.11. МАТРИЦЫ

33

Понятие суммируемости применимо и к рядам,

оо

Утверждение, что ряд 2 ak суммируем данным мето-

/г=0

дом, означает, что последовательность частных сумм

i

s = 2 суммируема этим методом. Например, при-

/г=0

меняя к частным суммам метод Чезаро, мы приходим

п-1

Sn — k

—~ ak'

k—0

1,11. Матрицы. Матрица — это прямоугольная таб-

лица чисел. Матрица размерности (порядка) г X s

имеет г строк, s столбцов и r-s элементов (или компо-

нент). В этой книге особую роль будут играть три спе-

циальных типа матриц. Матрица, у которой число строк

равно числу столбцов, называется квадратной. Другими

словами, это матрица размерности г X г. Если г=1,

т. е. если матрица состоит из одной строки, то мы на-

зываем ее вектор-строкой. Если 5=1, т. е. матрица со-

стоит из одного столбца, то мы называем ее вектор-

столбцом. Матрицы будут обозначаться прописными ла-

тинскими, а векторы — строчными греческими буквами.

Пусть матрица А размерности г X s имеет элемен-

ты а матрица В размерности г'X s' — элементы Ьц.

Определим следующие операции и соотношения.

(1) Матрица kA имеет элементы т. е. умноже-

ние матрицы на число означает умножение на это число

каждого элемента. Матрица —А — это (—1)Д.

(2) Если г = г' и s = s', то сумма А + В имеет эле-

менты a-ij + btj. Другими словами, сложение осуще-

ствляется покомпонентно.

(3) Если s = г', то мы определим произведение АВ

s

как матрицу С с элементами Сц = 2 atkbkp Заметим,

fe= I

что произведение матриц размерностей г X s и «X/ —

это матрица размерности г X t. Наше определение при-

менимо также к произведению вектор-строки на мат-

рицу, аЛ, и к произведению матрицы на вектор-стол-

бец Лр, В первом из этих случаев произведение матриц

3 Дж. Кемени, Дж. Снелл

34

ГЛ. 1. ПРЕДВАРИТЕЛЬНЫЕ СВЕДЕНИЯ

размерностей 1 X г и г X s представляет собой матрицу

размерности 1 X s, т. е. вектор-строку. Если матрица А

квадратная, то получающаяся вектор-строка имеет го

же число компонент, что и а. Поэтому квадратная мат-

рица задает преобразование вектор-строк. Аналогично,

она определяет преобразование и вектор-столбцов. Глав-

ным образом ради таких преобразований мы и будем

использовать умножение векторов на матрицы.

(4) Скажем, что 4>В (или что А = В), если

> bij (или ац = Ьц) для всех i и /. Другими сло-

вами, эти соотношения между матрицами должны вы-

полняться покомпонентно — для всех соответствующих

элементов.

(5) Важную роль играют некоторые специальные

матрицы. Матрица размерности г X s, все элементы ко-

торой равны 0, обозначается OrXs. Индекс внизу будет

опускаться, если это не может привести к недоразуме-

нию. Матрица размерности г X г, у которой равны I

элементы ац («элементы главной диагонали») и равны О

все прочие элементы, обозначается 1Г. И здесь индекс

часто опускается. Роль этих матриц видна из следую-

щего. Пусть 4, / и О —матрицы размерности г X г,

а-г-мерная вектор-строка и р— r-мерный вектор-стол-

бец. Тогда

Л+0=0+ 4 = 4,

4 + (—4) = (—4) + 4 = О,

д/ = М = 4,

а/ = а,

/Р = Р,

40 = 04 = 0,

ор = о,

аО = О.

Таким образом, матрицы О и / играют примерно ту же

роль, что и числа 0 и 1.

(6) По аналогии с обратными числами определим

обратную матрицу. Говорят, что матрица 4 размерно-

сти г X г имеет обратную матрицу В размерности г X G

если АВ — /. Если такая матрица В существует, то она

1.11. МАТРИЦЫ

35

обозначается А~1. Обратную матрицу можно найти, ре-

шив систему из г2 линейных уравнений. Конечно, эти

уравнения могут оказаться несовместными. Но если они

имеют решение, то оно единственно, и можно показать,

что АА~1 — А~1А = /.

Различные арифметические действия над матрицами,

если только они определены, удовлетворяют обычным

законам арифметики. Существенным исключением из

этого правила является лишь то, что матричное умно-

жение не коммутативно, т. е. АВ не обязательно рав-

но ВА. В одном важном случае коммутативность все же

имеет место. Это случай степеней данной матрицы.

Пусть Ап — это Л, умноженная на самое себя п раз.

Тогда АпАт = АтАп для любых т и п. По определению

мы полагаем 4° = I.

Удобно ввести вектор-строку т}г и вектор-столбец gr,

все компоненты которых равны 1. Когда это возможно,

мы будем опускать индекс и в этих обозначениях. Век-

торы г| и g удобно использовать при суммировании ком-

понент векторов или строк или столбцов матриц. Произ-

ведение — это число (или, точнее, матрица из одного

элемента), которое равно сумме компонент а. То же

самое можно сказать об г)Р. Произведение — это век-

тор-столбец, t-я компонента которого равна сумме эле-

ментов f-й строки матрицы А. Аналогично, тр4 дает

суммы компонент А по столбцам. Обозначим через Е

квадратную матрицу, все элементы которой равны 1.

Заметим, что Е =

Приведем некоторые примеры этих операций и соот-

ношений:

3f2 1\ /6 3\

АО -1/ а -з/’

/2 П /-1 °VP

А -1/А о —2/ а -з/;

(1,2, 3) + (2, 1,0) = (3, 3, 3);

/2 1 \

(1, 2, 3)1 0 -1 | = (5, -1);

\1 о/

3*

36

ГЛ. 1. ПРЕДВАРИТЕЛЬНЫЕ СВЕДЕНИЯ

2 3\

о

1\ / 72\ •

о >( о ;

-1/ \—2/

/2 iy 1 -п/ 1 -1V2 ИД1 °V/

\1 1Д-1 2/ 1 2Д1 1/ \О 1/ ’

так что

/ 1 -1\_/2 IV*

(-1 2/(1 1/ '

Для квадратной матрицы А определим транспониро-

ванную матрицу Ат Элемент матрицы Ат с индексами ij

есть /7-й элемент А. Введем также матрицу Adg, главная

диагональ которой совпадает с главной диагональю А,

а прочие элементы равны 0. Матрица ASq получается

из А возведением в квадрат каждого элемента. Она, ко-

нечно, как правило, не совпадает с А2. (Но D2 = Dsq

для диагональных матриц, т. е. матриц, у которых все

отличные от нуля элементы стоят на главной диаго-

нали.) Аналогично определяется aSq для вектора а.

Часто бывает удобно задавать матрицы и векторы

их компонентами Так, мы обозначаем через {а^} мат-

рицу, ij-и элемент которой равен ац. Аналогично, че-

рез {aj} обозначается вектор-строка, а через {aj—век-

тор-столбец Эти обозначения можно проиллюстрировать

следующими соотношениями:

{вц} + {Ьц} = {ац + Ьц}\

О = {0};

= £ =

= {ац}>

{ац}т = {«/J;

3{aJ = {3aJ;

Последний пример показывает, что произведение век-

тор столбца на вектор-строку (каждый из векторов

1.11. МАТРИЦЫ

37

имеет г компонент) есть матрица размерности г X г.

Сопоставьте это с тем, что то же произведение, взятое

в обратном порядке, представляет собой матрицу с

единственным элементом. Например, если а —вектор-

строка, то а| дает сумму компонент а. Однако ga — это

матрица размерности г X г, каждая строка которой

равна а.

Пусть задана последовательность матриц Ah с эле-

ментами a!ff. Будем говорить, что ряд Ао + At 4- Д2 + .. •

сходится, если каждый из рядов, образованных компо-

нентами, сходится, т. е. если ряд а<® + а(и + а® + ...

сходится при любых i и /. Если сумма последнего ряда

равна ац для каждой пары i, j и А — матрица с эле-

ментами dij, то мы скажем, что А есть сумма нашего

бесконечного ряда матриц. Короче говоря, бесконечная

сумма матриц определяется покомпонентно.

1.11.1. Теорема. Если матрица Ап стремится к О (ну-

левой матрице) при п-*оо, то матрица I — А имеет

обратную, причем

(/_Д)-1 = / + д + а2+ ... = £а\

ьо

Доказательство. Рассмотрим тождество

(/-А)(7 + А + А2 + ... +Ап-1) = /-Ап,

которое легко проверить, раскрывая скобки в левой ча-

сти. По предположению, правая часть стремится к /

при п—>оо. Матрица 1 имеет определитель 1. Значит,

при достаточно больших п определитель 7— Ап отличен

от 0. Так как определитель произведения двух матриц

равен произведению определителей, то определитель

7 — А также не равен’ 0. Но если определитель матрицы

отличен от 0, то она имеет обратную, так что / — А об-

ратима. Теперь можно умножить обе части тождества

на матрицу, обратную к I — А. Тогда получим

7 + А + А2 + ... + = (/ —А)~1(/ — Ап).

Ясно, что правая часть полученного равенства стремится

к (7— А)-1, чем и заканчивается доказательство тео-

ремы.

38 ГЛ. I. ПРЕДВАРИТЕЛЬНЫЕ СВЕДЕНИЯ

/Чожно определить суммируемость последовательно-

стей и рядов матриц точно так же, как это было сде-

лано в 1.10, применяя метод усреднения к каждой ком-

поненте. Тогда предыдущая теорема допускает следую-

щее обобщение. Если последовательность Ап суммируе-

ма к О каким-либо методом, то матрица / — Л имеет

обратную, причем ряд / + А 4- А2 4- ... суммируем к

(/ — Д)”1 тем же методом.

1.11.2. Определение. Квадратная матрица А назы-

вается неотрицательно определенной, если для любого

вектор-столбца у утАу 0.

1.11.3. Теорема. Для любой неотрицательно опреде-

ленной матрицы А найдется матрица В такая, что

А = ВТВ,

г Л А В A II

ОСНОВНЫЕ ПОНЯТИЯ ТЕОРИИ ЦЕПЕЙ МАРКОВА

2.1. Определение марковского процесса и цепи Мар-

кова. Вспомним, что для конечного стохастического про-

цесса мы уже определили дерево и меру на множестве

всех его путей, а также последовательность функций

исходов fn, п = О, I, 2, ... Область определения fn —

это дерево Тп, а область значений — множество Un воз-

можных исходов п-го эксперимента. Функция fn прини-

мает значение sj, если Sj— исход п-го эксперимента

(см. 1.9). Всякий раз, когда в последующих определе-

ниях появляется условная вероятность Р [q | р], предпо-

лагается, что высказывание р непротиворечиво. Чита-

тель, возможно, сочтет удобным время от времени обра-

щаться к списку основных понятий и обозначений, при-

веденному в конце книги.

Конечный стохастический процесс называется про-

цессом с независимыми значениями, если

(I) Для любого высказывания р, истинность которого

зависит лишь от исходов экспериментов до п-го,

P{fn = Sl\P} = P{fn^Sl}.

Для таких процессов знание исходов уже наблюдав-

шихся экспериментов не влияет на наш прогноз отно-

сительно последующего эксперимента. Для марковских

процессов мы ослабим это требование, допустив, что зна-

чение непосредственно предшествующего исхода влияет

на этот прогноз.

2.1.1. Определение. Конечным марковским процессом

называется конечный стохастический процесс такой, что

(II) Для любого высказывания р, истинность кото-

рого зависит лишь от исходов экспериментов до п-го,

р [fn = Sj | (f„-i = s() A p] = P = Sj I = s,]

(предполагается, что fn_i = Si u p совместимы).

40 ГЛ. II. ОСНОВНЫЕ ПОНЯТИЯ ТЕОРИИ ЦЕПЕЙ МАРКОВА

Мы будем называть условие (II) марковским свой-

ством1), Для марковских процессов знание исхода по-

следнего эксперимента позволяет пренебречь при пред-

сказании будущего любой другой информацией. Важно

понимать, что это верно лишь в том случае, когда исход

последнего эксперимента известен точно. Например, если

мы знаем только, что последний эксперимент привел

к исходу Si или sj, то знание того, истинно ли высказы-

вание р, связанное с предшествующими экспериментами,

может повлиять на наш прогноз будущего.

2.1.2. Определение. Переходные вероятности на

n-м шаге, которые будем обозначать р^, это

ЛIf.-,»»,]-

2.1.3. Определение. Конечной цепью Маркова назы-

вается конечный марковский процесс, для которого пе-

реходные вероятности pij(n) не зависят от п. В этом

случае они будут обозначаться рц. Элементы U назы-

ваются состояниями2).

2.1.4. Определение. Переходной матрицей цепи Мар-

кова называется матрица Р с элементами Pij- Вектором

начальных вероятностей {или начальным распределе-

нием) называется вектор л0 = {р9} = {Р [f0 = sjj.

Марковскую цепь можно представлять себе как про-

цесс, который движется из состояния в состояние. Он

начинается с вероятностью р(у0) в sr Если в какой-то

момент он находится в состоянии $г, то на следующем

«шаге» он попадает в з$ с вероятностью рц. Начальные

вероятности можно понимать как вероятности того или

иного возможного «старта». Вектор начальных вероят-

ностей вместе с переходной матрицей полностью опре-

!) В русской литературе термин «марковский процесс» приме-

няется обычно для обозначения стохастических процессов с непре-

рывным временем, удовлетворяющих марковскому свойству, а объ-

ект, определенный в 2.1.1, называется цепью Маркова с конечным

числом состояний. (Прим, ред.)

2) Стохастический процесс с таким определением в русской ли-

тературе принято называть однородной цепью Маркова с конечным

числом состояний. Неоднородные цепи, в которых переходные ве-

роятности зависят от п, в настоящей книге не рассматриваются.

(Прим, ред.)

2.1. ОПРЕДЕЛЕНИЕ МАРКОВСКОГО ПРОЦЕССА

41

деляют цепь Маркова как стохастический процесс, так

как их достаточно для построения полной меры на де-

реве. Поэтому если заданы некоторый вероятностный

вектор До и некоторая вероятностная матрица ’) Р, то

найдется единственная (с точностью до переобозначения

состояний) цепь Маркова, для которой ло— начальное

распределение, а Р —переходная матрица.

В большинстве случаев мы будем рассматривать фик-

сированную переходную матрицу Р, но менять при этом

начальный вектор л. Мера, заданная на дереве, будет,

конечно, зависеть от выбора начального распределения л.

Значит, если р — некоторое высказывание относительно

дерева или f — некоторая функция, областью определе-

ния которой служит дерево, то Р (р), М [fl и D [fl все

зависят от л. Мы будем указывать это, пользуясь обо-

значениями р«(р), мдя и оя[Л. В частном случае,

когда f-я компонента л равна 1 (процесс начинается

в состоянии Si), мы будем писать РДр), Mz[fl, Dz[fl.

В следующем пункте мы приведем несколько приме-

ров цепей Маркова. Настоящий параграф завершим не-

которыми замечаниями, относящимися к марковскому

свойству.

Легко доказать, что марковское свойство эквивалент-

но следующему свойству, формулировка которого более

симметрична.

(1Г) Пусть р— какое-нибудь высказывание, истин-

ность которого зависит от исходов экспериментов после

п-го, a q — какое-нибудь высказывание, истинность ко-

торого зависит от исходов экспериментов до п-го. Тогда

Р [р A q I fn = «/] = Р [р I fn = sj Р [q I fn = «/J.

Смысл этого условия в том, что при известном на-

стоящем прошлое и будущее процесса взаимно незави-

симы. Кроме того, это более, симметричное соотно-

шение наводит на мысль, что марковский процесс

должен остаться марковским, если наблюдения ведутся

9 Под вероятностным вектором понимается вектор с неотрица-

тельными элементами, дающими в сумме 1. Вероятностная матри-

ца— это квадратная матрица, все строки которой являются вероят-

ностными векторами. В русской литературе более распространен тер-

мин стохастическая матрица. (Прим, рев.)

42

ГЛ. II. ОСНОВНЫЕ ПОНЯТИЯ ТЕОРИИ ЦЕПЕЙ МАРКОВА

в обратном порядке. Справедливость этого факта выте-

кает из следующей теоремы (доказательство которой

мы не приводим). '

2.1.5. Теорема. Пусть для данного марковского про-

цесса р — какое-нибудь высказывание, истинность кото-

рого зависит от экспериментов после п-го. Тогда

Р [L = Sj I (f„+1 = Si Л p)l = P [f„ = Si I fn+i = Si].

Так как марковский процесс, наблюдаемый в обрат-

ном порядке, остается марковским, то естественно пред-

положить, что то же верно и для цепей Маркова. Так

будет в том случае, если «обращенные переходные ве-

роятности» p*tJ (n) = Р [fn = Sj | = $.] не зависят от п.

Эти вероятности можно найти следующим образом:

. (пХ pP« = g/A/n+i = ad _

p[Ui = M

Р [tt-H = *< I = »/] Р [Ь = */] РцР [ti ~ */]

PIU1-M р[/п+1=^'

Полученные переходные вероятности не зависят от п

только тогда, когда вероятность находиться в отдельном

состоянии в момент п от п не зависит. Это, конечно,

вообще говоря, не верно. Скажем, если система стар-

тует из состояния с вероятностью 1, то на следующем

шаге она окажется в S| с вероятностью рп. Поэтому,

вообще говоря, Р [f0 = s/] =/= Р [fi = sj. Итак, цепь Мар-

кова, рассматриваемая в обращенном времени, будет

марковским процессом, но переходные вероятности этого

процесса в общем случае зависят от времени и, значит,

он не является цепью Маркова. Мы вернемся к этому

вопросу в пункте 5.3.

2.2. Примеры. В этом пункте мы приведем несколько

простых примеров марковских цепей. Эти примеры бу-

дут в дальнейшем использоваться с иллюстративными

целями. Первые пять примеров связаны с так называе-

мым «случайным блужданием». Представим частицу, ко-

торая движется по прямой единичными шагами. Каж-

дый шаг направлен вправо с вероятностью р и влево

С вероятностью q. Частица движется, пока не достигнет

2.2. ПРИМЕРЫ

43

одной из двух крайних точек, которые называются «гра-

ничными точками». Возможные типы поведения частицы

в этих точках приводят к различным цепям Маркова. Со-

стояния цепи — возможные положения частиц. Рассмот-

рим случай 5 состояний, когда состояния и «5 будут

«граничными», а состояния $2, $з, $4 — «внутренними».

$ 1_____s2_____S3_____$5

Пример 1. Допустим, что процесс, достигнув состоя-

ний $1 или «5, остается там навсегда. В этом случае пе-

реходная матрица имеет вид

$2 $3 54 55

0 0 0 0

0 р о о

q 0 р 0

0 q 0 р

0 0 0 1

(1)

Пример 2. Допустим теперь, что частица, достигнув

граничной точки, «отражается» и возвращается в состоя-

ние, из которого она пришла. Другими словами, если

она когда-либо попала в Si, то на следующем шаге она

идет назад в «2- Если она попала в s5, то на следующем

шаге она возвращается в «4- Матрица переходных ве-

роятностей имеет в этом случае вид:

S1 «2 53 $4 S5

10 0 0

0 р 0 0

q 0 р 0

0 q 0 р

0 0 10

(2)

Пример 3. В качестве третьей возможности рассмот-

рим случай, когда частица, достигнув одного из гранич-

ных состояний, непосредственно направляется в цент-

ральное состояние «з- Можно представить себе, что в

44 ГЛ. II. ОСНОВНЫЕ ПОНЯТИЯ ТЕОРИИ ЦЕПЕЙ МАРКОВА

этом случае происходит процесс примера 1, начинаю-

щийся в s3 и возобновляющийся всякий раз после до-

стижения границы. Переходная матрица имеет вид

S| s2 S3 s4 s5

S| [ 0 0 1 0 0

CO N3 0 •X3 0 0

P = s3 0 q 0 p 0 (3)

s4 0 0 q 0 p

s5 0 0 1 0 0

Пример 4. Предположим теперь, что, достигнув од-

ного из граничных состояний, частица с вероятностью

7г в нем остается и с вероятностью 7г переходит в дру-

гое граничное состояние. В этом случае переходная мат-

рица имеет вид sl S2 S3 «4 «5

’/2 0 0 0 v2

S2 q 0 Р 0 0

P = s3 0 q 0 р 0 (4)

«4 0 0 q 0 р

S5 */2 0 0 0 '/J

Пример 5. В качестве последнего 1 типа граничного

поведения рассмотрим случай, когда частица, достигнув

однрй из границ, непосредственно переходит на другую.

Переходная матрица имеет вид

*2

P = s3

S4

S5

Sj S2

fo 0

я О

0 q

О О

Г О

S3 S4 S5

0 0 1

р о о

0 р о

р О р

ООО,

(5)

Пример 6. Рассмотрим теперь другой вариант слу-

чайного блуждания. Если частица находится в одном

из трех внутренних состояний, то она с равными вероят-

2.2. ПРИМЕРЫ

45

костями движется вправо, влево или остается на месте

Если частица находится на границе, то она не может

остаться на месте, и с равными вероятностями перехо-

дит в одно из четырех остальных состояний. Переходная

матрица имеет вид

Sj S2 S3 S4 S5

0 -/4 'Л 74 74

S2 73 7з 7з о о

Р ~ $3 о 7з 7з 7з о (6)

*4 о о 7з 7з 7з

55 74 74 74 74 о

Пример 7. Рассматривается последовательность

цифр, появляющихся случайно. Мы говорим, что про-

цесс находится в состоянии если появился 0, s2, если

появились 1 или 2, $з, если появились 3, 4, 5 или 6, «4,

если появились 7 или 8, и, наконец, $5, если появилась