Автор: Губарев В.В.

Теги: информационные технологии вычислительная техника обработка данных информатика

ISBN: 978-5-7782-2778-1

Год: 2015

Текст

Министерство образования и науки Российской Федерации

НОВОСИБИРСКИЙ ГОСУДАРСТВЕННЫЙ ТЕХНИЧЕСКИЙ УНИВЕРСИТЕТ

В.В. ГУБАРЕВ

ВВЕДЕНИЕ

В ТЕОРЕТИЧЕСКУЮ

ИНФОРМАТИКУ

Часть 2

Утверждено

Редакционно-издательским советом университета

в качестве учебного пособия

НОВОСИБИРСК

2015

УДК 004(075.8)

Г 93

Рецензенты:

Д.Е. Пальчунов, зав. кафедрой общей информатики,

зав. отделом ИДМИ НИЧ НГУ, д-р физ.-мат. наук, профессор

Б.Я. Рябко, зав. лабораторией информационных систем и защиты

информации ИВТ СО РАН, профессор НГУ, д-р техн. наук, профессор

Работа подготовлена на кафедре вычислительной техники

для студентов вузов, обучающихся по укрупненной группе

специальностей «Информатика и вычислительная техника»

(бакалавриат, магистратура, аспирантура)

Г 93

Губарев В.В.

Введение в теоретическую информатику: учеб. пособие /

В.В. Губарев. – Новосибирск: Изд-во НГТУ, 2015. – Ч. 2. – 472 с.

ISBN 978-5-7782-2778-1

В пособии с единых методических позиций рассматриваются системные

аспекты модельного представления объектов различной природы, излагаются

основные элементарные сведения теоретической информатики, ключевыми

словами которых являются: объект, модель, сигналы, данные, знания, алгоритмы, результат, информация, количество, качество. Описывается формальный

аппарат представления и исследования разнообразных видов процессов, структур, непрерывных и дискретных переходов состояний объектов.

Пособие ориентировано на подготовку бакалавров, магистров и аспирантов

по направлению 09.00.00 «Информатика и вычислительная техника». Оно может быть полезным для студентов, обучающихся по направлениям 02.00.00

«Компьютерные и информационные науки», 10.00.00 «Информационная безопасность», 11.00.00 «Электроника, радиотехника и системы связи», 27.00.00

«Управление в технических системах», а также специалистам в перечисленных

и смежных отраслях деятельности.

УДК 004(075.8)

ISBN 978-5-7782-2778-1

Губарев В.В, 2015

Новосибирский государственный

технический университет, 2015

ПРЕДИСЛОВИЕ

В первой части пособия (опубликованной в издательстве НГТУ в

2014 г.) излагаются элементарные основы моделирования, системного

представления, измерения и экспериментирования как методов исследования объектов, а также следующий формальный аппарат описания

и исследования объектов: детерминированный, стохастический, нечеткий; интервальный; поиска оптимальных решений; динамического хаоса, фракталов; теории игр и массового обслуживания.

Во второй части рассматриваются: аппарат распознавания образов,

классификации, кластеризации, теории графов и сетей, автоматов; разные модели представления данных и результатов для их визуального

анализа; аппарат синтактической обработки сигналов и данных (дискретизации и квантования сигналов для разных приложений; получения, оформления, хранения и передачи данных и знаний). Отдельно

рассмотрены принципы построения технических средств, в частности

аналоговые, цифровые, когнитивные, нейронные и квантовые. Завершает пособие обширная глава, посвященная семантическим, событийным и прагматическим аспектам обработки современных данных, а

именно: видам задач и алгоритмов; понятию «проблема» и ее решениям; элементам информологии, понятию «информация» и мерам ее количества; структуре и методам искусственного интеллекта; различным

мягким методам и алгоритмам (нейросетевым, генетическим, роевым,

агентным, иммунным, деревьям целей и регрессий, когнитивным, визуального моделирования, неопределенных вычислений); различным

индуктивным методам обработки и анализа сигналов, данных и знаний, включая упорядочение и выбор моделей, методов и алгоритмов,

интеллектуальный и разведочный анализы данных; инженерии знаний

и управления ими, а также квалиметрии моделей и управлению качеством результатов моделирования объектов и анализа сигналов, данных и знаний.

3

ВВЕДЕНИЕ

Пособие посвящено фрагментарному изложению с единых системно-методических позиций основных элементарных сведений о моделировании и экспериментировании как методах исследований1 объектов разной природы; метрологии; теории информации; методах и

алгоритмах обработки, исследования, анализа сигналов, данных,

знаний.

Основное внимание в первой части пособия (Издательство НГТУ,

2014 г.) уделено методологическим аспектам моделирования объектов,

элементам системологии, экспериментированию как методу исследования и этапу моделирования объектов, а также следующим элементарным основам аппарата описания и исследования объектов различной

природы: детерминированного, стохастического, нечеткого, экспертного, динамического хаоса, фрактального, оптимизационного и теории

массового обслуживания.

Во второй части учебного пособия вначале завершается изложение формального аппарата, используемого для описания исследуемых

объектов, методов и средств обработки (в обобщенном смысле) сигналов, данных и знаний. Рассмотрены элементарные сведения аппарата распознавания образов, классификации и кластеризации; теории

графов и сетей; теории автоматов; синтактической обработки сигналов, данных и знаний, а именно дискретизации по аргументу и квантования по значению сигналов с учетом разных назначений этих

операций; получения, оформления, хранения и передачи сигналов,

данных и знаний.

1

Напомним (см. часть 1, § 1.1), что в пособии термин исследование понимается, как правило, в обобщенном виде, а именно как изучение, познание,

представление, управление, проектирование, анализ, синтез, передача и т. п.

4

Кратко описаны важные для моделирования и обработки сигналов,

данных и знаний принципы построения используемых для этого технических средств: аналоговых, цифровых, когнитивных, нейронных и

квантовых.

Большое внимание во второй части пособия уделяется вопросам

отличия современных данных, в частности Больших данных, подходов

к их представлению и алгоритмов обработки от тех, которые использовались еще совсем недавно. Они связаны, во-первых, с особенностью

исходных, «сырых» данных, прежде всего Больших, во-вторых, с появлением новых типов задач, включая туманные, проблемные,

в-третьих, с необходимостью перехода от дедуктивных к индуктивным

методам работы с Данными = сигналами данными знаниями, в которых единственным исходным «источником» в работе являются только сами Данные, в-четвертых, вынужденностью расширения классов

алгоритмов на класс мягких алгоритмов и их применения для индуктивной обработки современных Данных при решении задач различной

сложности, в-пятых, с необходимостью использования полимодельного представления объектов и решения задач, и, как следствие, упорядочения, выбора, совместного применения моделей, оценки качества

получаемых при этом результатов и управления качеством в интересах

итогового результата решения стоящей задачи. К мягким относят теоретически нестрогие алгоритмы, позволяющие получить за определенное время неточное, приближенное, но приемлемое решение таких задач, которые традиционными алгоритмами не решаются в тех же

исходных условиях. Их особенность – настроенность не столько на

строгую теоретическую обоснованность механизма получения результата, сколько на его достижимость и пригодность.

Рассмотрены также вопросы информологии, искусственного интеллекта, инженерии знаний и управления ими, а также элементарные

основы принципов построения технических средств информатики.

В заключение отметим, что пособие сознательно рассчитано на

разный круг читателей – от начинающих студентов до специалистов.

Студентам рекомендуется при первом чтении опускать частности, различные замечания, уточнения, детализации и сноски, которые могут

представить несомненный интерес для специалистов и преподавателей. Это, естетственно, привело к неравномерности ширины и глубины

изложения отдельных вопросов, за что автор приносит свои извинения.

5

В силу определенной новизны и неоднозначности изложения многих вопросов в учебной и научной литературе, дискуссионного характера некоторых затронутых в пособии тем автор с благодарностью

примет любые деловые конструктивные замечания и пожелания по

уточнению и улучшению содержания книги.

Автор благодарен рецензентам, коллегам, ученикам, аспирантам и

студентам, замечания которых, беседы и дискуссии с которыми способствовали написанию книги и улучшению ее содержания. Особую

благодарность заслуживает О.В. Малявко за большой вклад в подготовку рукописи первой и второй части пособия.

6

Глава первая

ФОРМАЛЬНЫЙ АППАРАТ ОПИСАНИЯ

И ИССЛЕДОВАНИЯ РАЗНООБРАЗИЯ

СТРУКТУР И ДИСКРЕТНЫХ ПЕРЕХОДОВ

СОСТОЯНИЙ ОБЪЕКТОВ: КУАЛИЗНЫЕ МОДЕЛИ

§ 1.1. ВВОДНЫЕ ЗАМЕЧАНИЯ

В первой части пособия был рассмотрен формальный аппарат, который используется для куомодного механизмового модельного представления исследуемых объектов, отвечающего на вопросы: «Как, каким образом устроен и функционирует объект?». Основное внимание

при этом уделялось описанию механизма строения и функционирования с точки зрения динамики их проявления и развития. В настоящей

главе основное внимание уделяется рассмотрению моделей статики

строения объекта, т. е. его типа, состава, структуры и частично дискретного перехода из одного статичного состояния в другое. Иными

словами, такие модели призваны помочь получить ответы на вопросы

вида: «Что за объект, какой это объект, как он называется, как его отличить от других, включая отличие по структуре (составу и связям), в

каком состоянии он находится, как его перевести в другое состояние,

каково их разнообразие и т. п.?». Напомним, что под объектом в настоящем пособии понимается то первичное, на что направлено исследование. В качестве объектов могут быть вещи, процессы, явления, события, факты, сигналы, ситуации и прочее, а также их модели, включая

знания. Для этих моделей важно, чтобы исследуемые объекты можно

было охарактеризовать конечным набором их некоторых свойств, особенностей, называемых признаками.

7

§ 1.2. МОДЕЛИ РАЗНООБРАЗИЯ ОБЪЕКТОВ

1.2.1. Необходимые пояснения

Прежде всего рассмотрим куализные модели, направленные на получение ответов на вопросы: «Что это за объект? Каково их разнообразие? К какому виду он принадлежит? Как его называть?». Сюда относятся модели, используемые в теориях разнообразия: распознавания

образов, классификации1, кластеризации.

В первую очередь обратим внимание на два важных обстоятельства.

Первое обстоятельство. Ответы на упомянутые в начале параграфа вопросы требуют модельного представления объекта на основе некоторого набора его свойств, представляемых в виде количественных

или качественных признаков, по значениям которых исследователь

ищет ответы на эти вопросы. В связи с этим надо иметь в виду, что, вопервых, модель есть целевое отражение объекта-оригинала, вовторых, наборы свойств (признаков), их суть и состав есть также модели объекта-оригинала. Поэтому, с одной стороны, в зависимости от

куализного модельного представления объекта ответы на поставленные вопросы являются неоднозначными. Они будут зависеть как от

постановки задачи исследователя, в частности, от цели поиска ответа

на поставленные куализные вопросы, так и от взаимосвязанного с целью, но самостоятельно определяемого набора показателей, свойств,

признаков объекта, по которым исследователь будет искать ответ. Замена цели, а следовательно, и набора признаков, которыми характеризуется объект, либо замена одного набора признаков при той же цели

на другой могут привести к совершенно разным ответам на те же вопросы. С другой стороны, используя одно- или многовариантное решение, исследователь стремится получить четкий ответ на поставленный в исследовании вопрос. Иначе решение стоящей перед ним

практической задачи потребует дополнительных исследований. Это

противоречие является трудно формализуемым, так как затрагивает

вопросы постановки цели, количества и состава признаков, их ранжирования и важности для решаемой задачи с учетом ценностных, нрав1

Чтобы избежать перечисления этих терминов до специального рассмотрения их сути и отличия и в дальнейшем, где это не будет входить в противоречие с контекстом, будем использовать наиболее часто употребляемое, интуитивно понимаемое большинством в более широком контексте слово

«классификация».

8

ственных, этических, эстетических и прочих особенностей исследователя. Для формализации выбора признаков можно лишь предложить

некоторые общие рекомендации. Это, например, следующие.

1. Вводимые и используемые признаки должны быть существенными, т. е. отражать те особенности объекта, которые наиболее значимы для достижения поставленной цели классификации.

2. Желательно, чтобы набор признаков был «ортогональным», т. е.

таким, когда проекция количественных или качественных значений

любого из них на другие будет точечной, а не интервальной. Это, в

частности, означает, что не должно быть комбинированных, состоящих из совмещенных наименований, признаков.

3. Желательно, чтобы альтернативы названий признаков были бинарными либо, при невозможности бинарности, тринарными. Это

означает, что наименование признака должно иметь два или три варианта проявления, реализации, наборов количественных или качественных значений.

Приведем примеры признаков, когда приходится рассматривать

три их значения. Первый пример. Пол особи: чаще всего – мужской

или женский; иногда: мужской, женский и гермафродитный, когда

особь содержит одновременно мужские и женские органы и, как следствие, имеет свойства, признаки и мужского, и женского пола. Второй

пример – мезатермы – животные с промежуточным метаболизмом, т. е.

одновременно тепло- и холодокровные (предположительно динозавры). Третий пример – форма представления информации в информационной системе или принцип построения ее аппаратных, технических

элементов: как правило аналоговый, цифровой либо аналоговый, цифровой и гибридный, совмещающий одновременно признаки аналогового и цифрового представления информации (см. гл. 3). Но деление на

аналоговый, цифровой и комбинированный, когда под комбинированным понимается поочередное выполнение законченных аналоговых и

цифровых операций, с точки зрения классификации нежелательно.

В подобных ситуациях следует не вводить комбинированные принципы как варианты реализации признака, а рассматривать средства, основанные на комбинации двух принципов. Доведение признаков такого уровня детальности, когда их проявление может быть только

двояким и в случае невозможности дуальности трояким, представляет

собой один из способов выполнения требования ортогональности.

4. Необходимо соблюдать методологический принцип бережливости – «принцип достаточного основания», называемый Бритвой Оккамы (см. [1], 1320 г.), который кратко можно описать в виде «не следует

9

множить сущее без необходимости». В приложении к рассматриваемому это означает, что набор признаков следует делать бережливо, не

включать в него те, без которых поставленная задача может быть

успешно решена. Иными словами, набор признаков должен быть как

можно меньшим, но таким, чтобы задачу удалось решить с требуемым

качеством с минимальными затратами. Это приводит к необходимости

минимизации признакового пространства. Обратим внимание, что использование малого числа признаков может привести к пересечению

классов, что существенно усложняет процедуры и уменьшает качество

классификации. Заметим, что наличие в наборе ортогональных признаков означает на языке теории вероятностей, что количественные

признаки должны быть некоррелированы, т. е. не должны содержать

значений, общих данных, сведений об объекте, выраженных, может

быть, в другой форме или в другой шкале, либо разных признаков, связанно отражающих одну и ту же особенность, свойство объекта.

5. Признаки могут быть измерены в разных количественных и качественных шкалах и иметь разное модельное представление. Это

означает, что количественные признаки могут быть точечными или

интервальными; детерминированными, стохастическими, нечеткими

и т. д. (см. часть 1, гл. 4). Категорийные признаки могут быть номинальными или порядковыми; логическими – в виде высказываний, допускающих бинарные выводы (истина, ложь); отражающими состояние, поведение объекта (наличие насморка, кашля, определенного вида

боли, растворимости в воде, …), или структурными (лингвистические,

синтаксические), отражающими структуру объекта, составляющие его

элементы, связи и правила взаимодействия между собой элементов.

В связи с использованием разных измерительных шкал уместно

напомнить следующие моменты из их теории (см. часть 1, раздел

3.1.3). В шкалах наименований числа, как и имена, названия, используются только для персональной идентификации и различения объектов. Примерами таких чисел являются ИНН, штрих-коды, номера телефонов, паспортов, страховых свидетельств и т. п. В порядковых

шкалах числа используются для упорядочения объектов: оценки на

экзаменах, номера домов и квартир, различные баллы.

В интервальных шкалах начала отсчета и единица измерения назначаются произвольно (например, температурные шкалы Цельсия,

Фаренгейта; положение точки относительно какого-то центра). В шкале же отношений единица измерения может быть произвольной, но

начало отсчета всегда считается заданным (масса, мощность, сила тока, температура по Кельвину, сопротивление, цена, электрическое или

10

магнитное напряжение, давление и т. п.). Наоборот, в шкале разностей

задается единица измерения, а начало отсчетов может быть произвольным (например, время, продолжительность жизни). И только в абсолютной шкале задаются как начало отсчета, так и единица измерения.

Второе обстоятельство. Оно связано с тем, что разные специалисты одни и те же термины используют по-разному.

Это обусловлено рядом причин, одни из которых изложены в части 1

в первой главе, другие будут обсуждаться в четвертой главе, часть 2.

Здесь только заметим следующее. Во-первых, любой термин лишь модель определяемого им понятия (см. часть 1, гл. 1) и поэтому неоднозначно отражает его. Во-вторых, междисциплинарные понятия, как

правило, являются по сути своей дефинициями с нечеткими границами. В-третьих, термины, особенно новые, междисциплинарные, часто

вводятся и используются на интуитивном уровне. В-четвертых,

общепринятые понятия окончательно появляются в тех научных дисциплинах, базовые основы которых становятся классическими и практически перестают развиваться. В-пятых, человеку свойственно образное мышление, поэтому зачастую ему, особенно ребенку, проще

показать объект, соответствующий какому-то понятию либо классу,

образу, чем дать определение этого объекта (класса, образа).

В-шестых, иногда термин обозначает как процесс, а порою и метод

действия, так и результат действия, определяемого этим или схожим

термином (например, оценка (см. 1-ю часть) и классификация (см.

настоящий параграф)). Наконец, в-седьмых, чрезмерно ограничительное определение (дефиниция) на стадии введения новых терминов,

особенно на этапе становления научной дисциплины, может оказаться

чрезмерно сковывающим, сравнимым, по меткому выражению

Л.И. Мандельштама1, с губительным пристрастием заворачивать младенца в колючую проволоку. Это вовсе не означает то, что термины

можно вводить произвольно, а лишь отражает сложность введения и

толкования разными специалистами одних и тех же терминов. Именно

поэтому в первой части пособия введено понятие «рабочее определение» термина.

1

Л.И. Мандельштам (см. о нем в [1]) обсуждал вопросы определения термина «колебания» и того, что составляет предмет теории колебаний. О подобных сложностях с определениями пишет Дж. Уизем, который отмечает, что,

по-видимому, не существует единого строгого определения волнам …, поскольку различным типам волн присущи различные характерные черты (Образование и общество. – 2010. – № 3. – С. 72–75).

11

Воспользуемся этим приемом. Далее нам придется подробно рассматривать термины «класс» и «классификация». Но до их детального

рассмотрения придется эти термины использовать.

В связи с этим приведем здесь их «рабочее» понимание. Чтобы избежать повтора, приведем разные трактовки терминов класс и классификация. Использование энциклопедического, специализированного

или конкретного понимания трактовки термина будет, надеемся, ясным из дальнейшего контекста.

Класс (от лат.– разряд, группа) это:

единица классификации в различных научных дисциплинах и

областях деятельности;

совокупность (разряд, группа, множество)1 объектов (предметов,

явлений) – экземпляров, элементов класса, обладающих общими признаками, выделенных и включенных в нее (совокупность) по этим признакам;

подмножество объектов, выделенное из бесконечного множества

объектов с определенной целью [5];

«генеральная совокупность, описываемая одномерным распределением вероятности» (в задачах статистической классификации) [9].

Под «классификацией» (от лат. classis и facere – делать) в обобщенном виде будем понимать, во-первых, систему классов; действия,

связанные с построением системы, а именно процедуры построения

классов, их изучения и использования (триаду «построение – изучение –

применение»), и саму построенную систему классов; во-вторых, метод

исследования объектов, основанный на выделении и изучении классов

и отнесение конкретного объекта к определенному классу. Заметим,

что этап классификации, связанный с отнесением объекта к тому или

иному классу с известным или создаваемым в ходе классификации

описанием, представляет собой идентификацию (параметрическую или

структурную) объекта куализной моделью. Именно в этом (куализном)

смысле логично понимать термин идентификация, иногда используемый в теории классификации рядом авторов (ср. с рис. 2.3, часть 1).

Все изложенное в полной мере относится к приводимым ниже терминам «распознавание» (образов), «классификация», «кластеризация»,

«таксономия» и т. п. Это затрудняет написание учебного пособия и

приводит к необходимости либо присоединиться к одной из групп

специалистов, либо к рассмотрению разных трактовок часто использу1

Желательно иметь и строить не просто множество, совокупность, а

именно систему классов, обладающую свойством эмерджентности.

12

емых определений, либо вводить уточнение, свое содержание терминов. Понятно, что в первом и третьем случаях это может не очень нравиться и воспринято специалистами, работающими в узкой сфере, а во

втором случае затруднит конкретное изложение сути моделей и методов, чтобы не ввести в заблуждение обучающихся. Приведем некоторые пояснения изложенному.

1.2.2. Абстрагирование как необходимый этап

моделирования объектов

Прежде всего введем необходимые понятия.

Одним из классических приемов при построении различных моделей реальности, в частности при установлении физических законов и

закономерностей, является абстрагирование, проявляющееся в использовании разных типов абстракции. Чаще всего выделяют следующие

четыре типа: изолирующая – вычленяющая исследуемый объект из некоторой целостности; обобщающая – дающая обобщающую картину

объекта; идеализирующая – замещающая реальный объект идеализированным в каком-то смысле объектом; мысленная – придуманная человеком без обязательной привязки к действительности (например, математические понятия, конструкции, аксиомы).

Методы, основанные на абстрагировании, на абстракции, – это

методы, базирующиеся на мысленном отвлечении от несущественных

свойств, связей, отношений объектов (предметов, явлений, процессов)

и на выделении тех из них, которые интересуют исследователя. Они

широко используются и содержат две явно различимые стадии: выявление, определение несущественных связей, свойств и замена исследуемого объекта моделью – другим объектом, сохраняющим главное в

сложном. Из изложенного ясно, что абстрагирование – это один из

важных этапов моделирования.

Как было отмечено, в моделировании абстракция бывает четырех

основных типов: изолирующей, обобщающей, идеализирующей и

мысленной. Что касается общенаучных видов абстрагирования, то выделяют обычно следующие: отождествление – образование понятий,

моделей путем объединения объектов по их свойствам в определенные

классы; изолирование – выделение свойств, неразрывно связанных с

объектом, и оперирование ими; конструктивизация – отвлечение от

неопределенности границ реальных объектов, их четкое очерчивание,

выделение; виртуализация – выявление допустимости потенциальной

13

осуществимости объекта, т. е. принципиально реализуемой, существующей в потенции, могущей быть реализованной в определенных

реальных условиях при наличии определенных средств, ресурсов, сил,

условий и других необходимых возможностей.

Например, в семантических моделях (структурах) Данных (см.

далее), учитывающих смысловое содержание Данных и смысловые

аспекты информации, для послойного рассмотрения проблемы, решения задачи на базе Данных, семантики знаний с отвлечением на каждом этапе решения от несущественных деталей и выделением принципиально важных фактов, используют наиболее часто следующие

абстракции: классификацию, агрегирование, обобщение и ассоциацию.

При классификации1, как методе исследования, осуществляется

распределение исследуемых объектов на взаимосвязанные классы по

наиболее существенным признакам, присущим объектам данного рода

и отличающим их от объектов других родов. При этом признаки, как

было указано, должны быть «ортогональными», относиться к разным

(«перпендикулярным») ортам системы координат признаков, а каждый

класс занимает в получившейся системе определенное постоянное место и, в свою очередь, может делиться на подклассы. Таким образом,

при классификации набор объектов рассматривается как новый объект

более высокого уровня – класс объектов, характеризующий свойства

каждого принадлежащего ему объекта. Это абстракция, в которой

связь между объектами и их свойствами, признаками представляется

по типу «экземпляр чего-либо». Например, распределение студентов

по полу, успеваемости и т. п.

Заметим, что в основе любой классификации лежат следующие два

принципа: 1) в один класс объединяются объекты, сходные между собой в принятом смысле; 2) степень сходства между собой объектов,

относимых к одному классу, должна быть больше, чем степень сходства между собой объектов, включаемых в разные классы [8]. При

этом, во-первых, число реально существующих классов всегда меньше

числа всевозможных сочетаний различных признаков, используемых

при классификации; во-вторых, элементы разных классов должны взаимно исключать друг друга; в-третьих, общее число расквалифицированных объектов должно равняться сумме объектов, включенных во

1

Термин классификация здесь понимается обобщенно и как система классов, и как построенная классификация, и как действия, связанные с процедурой выделения классов и отнесения объектов к ним.

14

все классы; в-четвертых, для одной и той же классификации должно

применяться одно и то же основание.

Обобщение – форма абстракции, посредством которой осуществляется переход от единичного к общему, от менее общего к более общему путем выделения одинаковых свойств объектов, принадлежащих

определенным группам, когда похожие объекты связываются с родовым объектом более высокого уровня и рассматриваются как его частные случаи (ср. с дедукцией), т. е. когда вводится, определяется новое

понятие, в котором находит отражение главное, основное, характеризующее объекты определенной группы, класса. Например, объекты

«университет», «академия» (учебная), «институт» есть частные случаи

объекта «вуз». Обобщение есть одно из основных средств для образования новых понятий, формулирования закономерностей, законов,

теорий. При обобщении связь между объектами представляется как

«это есть».

При агрегировании (от лат. aggregatus – присоединенный) рассматриваются не столько сами объекты, сколько связи между ними, свойства, однородные показатели, т. е. когда объекты рассматриваются через свои связи, свойства, показатели путем объединения их в объекты

(агрегаты) более высокого уровня, не отражающие (в определенном

смысле даже подавляющие) специфические детали исходных составляющих их объектов. С помощью данной абстракции обеспечивается

установление между объектами связи вида «часть чего-либо». Заметим, что объекты, входящие в агрегат, называются именно частями в

отличие от объектов, входящих во множество, в котором они называются элементами, или в классы, где их лучше в данном понимании

называть экземплярами.

Признаки агрегата, как совокупности однородных объектов, отображенные в понятии о нем, характеризуют лишь именно агрегат в целом, но не приложимы к каждому отдельному объекту этой совокупности. Например, в понятии «лес» отображены признаки совокупности

деревьев, входящих в этот агрегат, но существенные признаки этого

понятия нельзя приложить к каждому отдельному дереву: понятие

«строевой или хвойный лес» вовсе не означает, что все деревья этого

леса годны для строительства или являются хвойными. Именно это

отличает агрегат от класса, поскольку класс – это совокупность единичных объектов, когда каждому из них присущи одни и те же общие

свойства (например, животные, входящие в класс млекопитающих, все

имеют молочные железы, постоянную температуру тела, легочное дыхание и др.).

15

Таким образом, с помощью агрегирования, как формы абстракции,

обеспечивается установление между объектами связей вида «часть

чего-либо».

Наконец, ассоциация (от лат. associatio – соединение) – это форма

абстракции, устанавливающая связь между объектами, заключающаяся

в том, что появление при определенных условиях одного объекта влечет за собой появление другого или нескольких ассоциируемых с ним

объектов. Иными словами, это форма абстракции, оперирующая взаимосвязью между подобными объектами, которая рассматривается как

некоторый множественный объект более высокого уровня. Например,

множественный объект типа «персонал» определяется через составляющие объекты типа «сотрудник». При ассоциации между объектами

устанавливается связь вида «член чего-либо», причем сама связь заключается в том, что появление при определенных условиях одного

объекта влечет за собой появление другого или нескольких объектов.

Так, например, в ассоциативных запоминающих устройствах (ЗУ)

запись и/или выборка данных производится не по конкретному адресу

(как в адресных ЗУ), а путем ассоциативного поиска, т. е. по заданному сочетанию (ассоциации) признаков, свойственных искомой информации: часть, особенность или размер слова или его местоположение в

словосочетании. В ассоциативном программировании решение информационно-логических задач основано на программной реализации

ассоциативных связей между данными, хранящимися в ЗУ или в базе

данных. В средствах искусственного интеллекта помимо ассоциативного поиска применяются модели ассоциативных рассуждений, основанные на переносе приемов, использованных ранее, на текущую ситуацию. Ассоциативный поиск и ассоциативное рассуждение есть два

составных компонента исследуемых в психологии ассоциативных моделей мышления, основой которых является предположение о том, что

решение неизвестной задачи так или иначе базируется на уже решенных задачах, чем-то похожих на ту, которую надо решить, т. е. когда

новая задача рассматривается как уже известная, хотя и несколько отличная от нее, и поэтому может быть решена способом, близким к способу, позволяющему решить известную задачу. Структуры данных,

использующие семантические модели указанных четырех типов, представляются в виде соответствующих форм абстракции, каждая из которых может строиться в виде иерархической системы, подобной

«классическим» (см. далее).

16

1.2.3. О терминах «кластеризация», «группирование»,

«таксономия», «распознавание образов»

Прежде чем осуществлять классификацию, т. е. отнести какой-либо

объект к определенному классу, упорядочить объекты по их схожести,

необходимо выделить классы. Это можно сделать двумя путями: априори и апостериори. При априорном выделении классов сначала, исходя

из целей классификации, формализуются признаки классификации,

которые затем, оформляясь в достаточное множество, кладутся в основу описания классов, отделения одного класса от другого. Это, например, классификации в биологии, географии, геологии, библиотечном

деле, химических элементов, продукции и т. п. При этом можно использовать формальные процедуры для определения по экспериментальным данным ортогональности признаков и их информативность

[2, 3]. При апостериорном выделении классов исследователь располагает эмпирической выборкой (экспериментальными данными) и по

ним, используя формальные приемы, в частности различные меры расстояний между объектами, апостериори строит классы. Это разбиение

на группы отраслей промышленности или однородной продукции, задачи технической и медицинской диагностики, использующие приемы

распознавания образов, дискриминантного анализа, таксономии и

группирования, кластеризации.

Таксономия (от греч. táxis – расположение, строй, порядок и nómos –

закон) это: 1) теория классификации и систематизации сложно-организованных областей действительности (реальности), имеющих обычно

иерархическое строение; 2) выделение по эмпирическим данным типа

объект-свойства областей похожести объектов-таксонов и распределение объектов по ним; 3) автоматическая апостериорная классификация. При иерархической таксономии отношения между таксонами разных уровней можно представить себе в виде иерархической структуры

или дерева, состоящего из m объектов на нулевом уровне (уровень листьев) и Ki таксонов ( i 1,..., p) на каждом из p уровней [4]. Динамическая таксономия делается не на одновременно заданном множестве

объектов, а на объектах, возникающих по одному или небольшими

группами в ходе экспериментального исследования объектов [4].

Заметим, что как правило при решении задач таксономии на первое

место ставится максимизация связи внутри таксонов и минимизация их

между таксонами без учета назначения, цели, процедуры таксономизации. Если решения этих задач минимизации и максимизации достигаются в процессе таксономии автоматически, то иногда говорят об обу17

чении без учителя, или самообучении. Тогда под таксономией понимают только такие ее варианты, когда цели таксономии четко фиксируются до расчетов.

Заметим, что внешне кажущаяся объективной на самом деле таксономия является объективно-субъективной. Субъект всегда присутствует, в частности, на этапе выделения свойств объектов при формировании данных по типу объект-свойство, при выборе мер близости,

критериев качества, цели и т. п. [4].

Одним из вариантов такой таксономии является группирование или

кластеризация. Цель кластеризации и группирования – выявление и

выделение классов по эмпирическим данным. Под группированием

обычно понимают объединение в группы и расположение группой

(группами) независимо от того, естественны ли границы разбиения.

Под кластеризацией (от англ. cluster – кластер, гроздь, скопление

и от лат. facio – делаю) здесь понимается либо синоним понятия группирование, либо операции, связанные с процедурой, которая преобразует исходные данные в данные о кластерах, в частности, с процедурой

вычисления индексов сходства и различия. Обычно под кластером понимается группа наиболее близких друг к другу объектов [4].

Задача кластеризации (кластер-анализа) – обнаружение естественного разбиения на классы, свободного от субъективизма исследователя, выявление по эмпирическим данным, насколько элементы

«группируются» или распадаются на изолированные «скопления»,

«кластеры», а цель – выделение групп однородных объектов, сходных

между собой, при резком отличии этих групп друг от друга. При группировании и кластеризации основное – это выбор метрики, мер расстояния между объектами, мер близости, сходства и/или различия,

адекватных решаемой прикладной задаче. Заметим, что если решение

задачи кластеризации существует, то в отличие от группирования оно

может быть найдено с помощью любого (лучше наиболее простого)

алгоритма.

Обычно при классификации выделяют следующие начальные фазы

[3]: первая фаза – восприятие объектов и получение данных; вторая –

описание объекта с помощью признаков; третья – классификация либо

кластеризация, группирование, распознавание образов и т. д.

Промежуточное положение между априорной классификацией и

апостериорными группированием и кластеризацией занимает дискриминантный анализ. В нем математические классы предполагаются

априори заданными либо обучающей выборкой, либо плотностями

распределения вероятностей, а задача состоит в том, чтобы построить

18

разделяющую поверхность и вновь поступающий объект отнести в

один из этих классов. Синонимами термина «дискриминация» (от лат.

discrimination – различение, разделение) являются диагностика, иногда

«распознавание образов» с учителем, автоматическая классификация с

учителем, статистическая классификация и т. д. (см. далее). При этом

для построения системы диагностических классов применяют группирование или кластеризацию. Предметом дискриминантного анализа

является диагностика – процедура использовая классификации – отнесения вновь поступающего объекта к одному из выделенных классов, поскольку основная задача диагностики – отнесение той или иной

реальной ситуации с объектом к одному из имеющихся классов ситуаций [8]. Заметим, что иногда в медицинской диагностике предпочтение

отдается гипердиагностике, когда рациональнее часть легких больных

объявить тяжелыми, чем наоборот.

Наконец, распознавание образов (паттернов [7]) – определение

(выбор) имени образа (класса) из построенных в итоге таксономий,

которому принадлежит некоторый новый объект.

Применяя таксономию, исследователь создает начальную классификацию S ( S1 , S2 ,..., Sk ) множества m объектов. Если после предъявления нового объекта, не участвовавшего в таксономии, требуется

отнести к одному из этих классов, то, анализируя характеристики этого

объекта, необходимо распознать образ того класса Si , i 1, k , на который данный объект наиболее похож. Именно эта процедура и называется распознаванием образов. Процесс распознавания обычно состоит

из двух этапов: обучения и принятия решения. На этапе обучения происходит обнаружение закономерности связи между значениями характеристик, описывающих объект, и значением целевой функции – значения из шкалы наименований, который соответствует классу Si . На

этапе принятия решений и происходит собственно распознавание.

1.2.4. Другие определения терминов

Рассмотрим другие точки зрения. Для примера приведем цитаты и

некоторые идеи из [5].

Распознавание – это «задачи и методы, которые имеют дело с классификационной выборкой, для объектов которой известны значения

как описывающих, так и целевых признаков. Эта задача включает в

себя: 1) процесс “обучения”, т. е. обнаружения закономерностей связи

между значениями описывающих и целевых характеристик и форму19

лировки этих закономерностей (знаний) в виде “решающих правил” и

2) процесс использования этих правил для определения принадлежности контрольного объекта к тому или иному образцу. Контрольный

объект считается принадлежащим тому образу, на обучающие объекты

которого по описываемым характеристикам он похож больше, чем на

объекты других образов». Отметим, что в [5] образ считается синонимом класса, элементы (объекты) которого представлены своими индивидуальными «описывающими» характеристиками, по значению которых они похожи друг на друга и отличаются от объектов других

образов. Они также имеют еще одну «целевую» характеристику, измеряемую в номинальной шкале, – имя образа, по которому объекты одного образа неразличимы. Именно поэтому такие модельные представления объектов называются в настоящем пособии куализными.

В [5] приводятся свои понятия классифицирования, классификации, а также рассматривается задача анализа «полуклассификационной» выборки, занимающей промежуточное положение, когда для

одних объектов известны значения описывающих и целевых характеристик, а для других – значения только описывающих характеристик.

В этих случаях задача решается с применением таксономических решающих правил.

Под таксономией в [5] понимается формирование и продукт иерархических классификаций, а под «таксоном» или «кластером» понимаются элементы такой иерархической структуры. При этом отмечается,

что формирование классов одного уровня часто тоже называется

таксономией, а словом «кластер» обозначает таксон (класс, образ), который отделяется от любого другого таксона простой линейной границей. Все три случая являются частными случаями универсальной классификации.

В заключение обратим внимание на появление нового «междисциплинарного» термина «классификационные измерения» автометрия,

под которым понимается разновидность измерений, в процессе которых устанавливаются априори нечетко определенные состав и суть

обозначений (имен классов) категорийной измерительной шкалы, а

результатом является отнесение конкретного единичного объекта к

одному из выбранных классов.

В Википедии можно найти определение теории распознавания образов как «раздел информатики и смежных дисциплин1, развивающий основы и методы классификации, идентификации … объектов, которые

1

Не ясно, каких.

20

характеризуются конечным набором некоторых свойств и признаков», а

распознавание образов как «отнесение исходных данных к определенному классу с помощью выделения существенных признаков, характеризующих эти данные, из общей массы несущественных данных».

Здесь же под кластеризацией или автоматической классификацией,

ботриологией, понимается многомерная статистическая процедура, выполняющая сбор данных, содержащих информацию о выборке объектов,

и затем упорядочивающая объекты в сравнительно однородные группы.

Не вдаваясь далее в рассмотрение разных определений, завершим

подраздел итоговым упрощенным изложением отличий в понимании

терминов как научной дисциплины и процесса, действия.

Распознавание образов (РО) (в обобщенном понятии) – раздел

информатики, занимающийся способностями субъектов, моделями,

средствами и технологиями исследования разнообразия объектов действительности разной природы.

Как фундаментальная научная дисциплина РО изучает и разрабатывает теоретические основы познания, обнаружения принципов, законов и закономерностей способности живых существ к выявлению

разнообразий действительности и их распознаванию (классификации,

кластеризации), создает теории для объяснения и моделирования таких

способностей.

Как прикладная научная дисциплина РО формирует теоретические

основы построения искусственных средств, предназначенных для решения задач распознавания объектов (предметов, состояний, процессов,

явлений, …), их классификации и кластеризации в прикладных целях.

Как область практической деятельности РО занимается реальным

созданием и применением этих средств.

Распознавание образов (в изначальном1, узком, понимании) – это:

а) определение «образцов», «шаблонов», к которым следует отнести конкретный (тестируемый, исследуемый) объект (например, определение почтового индекса по цифрам на конверте; кубика, трапеции

или шара, соответствующего подобной игрушке в руках; разрешенной

кодовой комбинации по принятой в канале связи с помехами комбинации и т. д.);

1

Термин «Распознавание образов» изначально появился от неудачного

перевода с английского «Pattern recognition», в котором «Pattern» означает

«образец», «образчик», «шаблон», «выкройка», а также «модель» (в дизайне,

проекте, плане, конструкции), «образ», «манера» (в аранжировке, теории

систем).

21

б) выбор «образа», понимаемого как совокупность (класс) образцов

(близких к цифре или букве ее написаний или произношений, «искаженных кубиков», кодовых комбинаций, полученных в канале связи с

помехами, которые могут получиться от разрешенной комбинации;

класс автомобилей ВАЗ и т. д.).

Формальное описание задачи РО

Дано:

1) совокупность «образцов», «шаблонов», классов объектов 1,

2, … , т, представленных совокупностью значений признаков х1,…,

хт, xl ( x1,l ,..., xn,l ) , l 1, m ;

2) тестируемый объект Oi , i 1, N , имеющий значение признаков

xi ( x1,i , x2,i ..., xn,i ) .

Необходимо: по значениям xi определить, какой «образец», «шабl 1, m соответствует тестируемому объекту Oi ,

i 1, N , или, наоборот, какому образцу l соответствует объект Oi .

Искусственный метод решения: вводится мера ( ,О) сходства

(близости, схожести) между образцом и объектом О, находятся ее

эмпирические значения для всех l 1, m и согласно принятому решающему правилу выбирается соответствующий «образец». Например,

эмпирические значения ( l, Оi) сравниваются между собой и для Оi

выбирается тот s-й «образец» s, для которого значение ( s, Оi) будет

наименьшим.

Реализация метода, т. е. выбор набора классов, их описания, решающего правила и варианта его использования, зависит от условий

метода: с обучением (с учителем), когда имеется и используется априорная прецедентная информация об «образцах» (образах, классах) и

правильном отнесении их к объектам (или объектов к ним) (распознавание с обучением, с учителем, классификация); без обучения (без

учителя), когда информации об образцах (образах, классах) и/или правильном отнесении объектов к ним (правильной классификации) априори нет и ее надо получить апостериори по имеющемуся эмпирическому материалу (распознавание, классификация без обучения, без

учителя, или кластеризация); смешанные, когда прецедентной априорной информации недостаточно для хорошего обучения, но она позволяет упростить распознавание и/или повысить его качество.

лон», класс

l,

22

Классифицирование:

отнесение объекта к определенному классу;

упорядочение объектов по их схожести;

разбиение неклассифицированной выборки на непересекающиеся подмножества, для объектов которой известны значения только

описывающих характеристик [5].

Классификация:

естественное или искусственное классифицирование объектов по

априори выделенным (исходя из целей классификации) классам (биология, география, геология; библиотека; химические элементы и т. п.);

конкретный результат классифицирования;

результат классифицирования по [5] в виде перечня классов с

указанием правил, по которым каждый класс можно отличить от

остальных [5];

«разделение рассматриваемой совокупности объектов или явлений на однородные (в определенном смысле) группы (как процесс или

его результат)» [9].

Формальное описание задачи

Дано:

формализованные признаки x (Oi ) xi ( x1,i ,..., xn,i ) классифи-

кации объектов O1 ,..., ON ;

заданный набор т классов K1 ,..., K m , отличающихся значениями

признаков x ( Kl ) l x ( l x1 ,..., l xn ) , l 1, m ;

один или несколько тестируемых объектов.

Необходимо: отнести эти объекты Oi , i 1, N (упорядочить их) по

разных классам Kl , l 1, m .

Метод: используется мера близости (сходства) объектов (Oi , O j )

внутри и вне классов и тестируемый объект Oi относится к соответствующему классу Kl согласно принятому решающему правилу.

Например, выбирается такой класс K s , для которого ( xi , s x ) меньше, чем для других l 1, m , l s .

Таксономия:

научная дисциплина и область деятельности, связанные с автоматической апостериорной классификацией объектов;

23

выделение по эмпирическим данным (типа таблиц «объект –

свойства» или кубов «объект – свойства – моменты времени») областей похожести объектов (таксонов) и распределение тестируемых

объектов по ним.

Формальное описание задачи

Дано:

множество структурированных, например сведенных в таблицу

или куб, эмпирических данных;

один или несколько тестируемых объектов.

Необходимо: определить области «сгущения» объектов в пространстве свойств (признаков), выделить набор таких таксонов и распределить объекты по этим таксонам.

Методы: максимизация (или минимизация) значений меры близости (связи) внутри таксонов и минимизация (максимизация) их между

таксонами без учета назначения, цели, процедуры таксономии.

Динамическая таксономия – делается не на всем множестве

объектов, а каждый раз по мере поступления новых тестируемых

объектов.

Чаще всего таксономию связывают с иерархической классификацией.

Кластеризация (группирование):

этап таксономии, связанный с выявлением и выделением свободных от субъективизма кластеров (групп) по эмпирическим данным;

прикладная разновидность таксономии – автоматическая апостериорная классификация.

Цель – выделение компактных групп однородных объектов, сходных между собой, при резком отличии этих групп друг от друга.

Основная проблема – выбор метрики, мер компактности кластеров,

расстояний между объектами, их близости, схожести и/или различия,

адекватных прикладной задаче. Именно конкретика, привязка к назначению отличает кластеризацию от «чистой» таксономии.

Формализованная постановка классификационных (кластеризационных) задач

Дано: Множество M (O1 ,..., ON ) N объектов Oi , i 1, N ,

имеющих одинаковые по составу для всех объектов, но разные по значениям описания I ( ) x1 (),..., xn () , где x j – значение показателя

x j ( ) – реализация классификационного признака x j объекта ,

j 1, n , п – размерность признакового пространства (число признаков).

24

Задан (выбран или разработан) исследователем критерий {I ()} ,

позволяющий отличать объекты друг от друга в определенных условиях, и, возможно, критерий L{i , j } , i, j 1, m , – позволяющий отличать классы i и j друг от друга.

Требуется: используя критерии () и L() , во-первых, разбить

наилучшим по выбранному критерию множество М на т непересекающихся (чаще наиболее желательно) или пересекающихся классов

j:

m

j , априори определенных при классификации или апо-

j0

стериори определяемых при кластеризации, во-вторых, построить решающее правило, позволяющее любой объект отнести к одному конкретному классу или (в случае пересекающихся его подклассов) к

определенному подмножеству классов, в-третьих, разработать меру качества результатов классификации (кластеризации), а в приложениях –

решения прикладной задачи с использованием классификации, кластеризации. При этом

l , j , l , j 1, m , l j I ( l ) I ( j ) ;

0, l j ,

L{l , j }

как можно большему значению при l j ,

а разбиение желательно сделать таким, чтобы классы были как можно

более компактными с точки зрения принятой меры компактности.

Дискриминантный анализ – апостериорное построение поверхностей, разделяющих классы (кластеры), и отнесение вновь поступающего

объекта к одному из разделенных классов. Это этап автоматической

классификации или кластеризации с учителем, т. е. с начальным обучением по «образцам».

Формальное описание задачи

Дано:

априори заданные классы или апостериори полученные по обучающей выборке кластеры (таксоны, группы) 1, … , т,;

вновь поступивший объект Oi , i 1, N .

25

Необходимо:

построить разделяющую поверхность в п-мерном признаковом

пространстве, описывающем классы (кластеры);

отнести поступивший объект к одному из классов, используя эту

разделяющую классы (кластеры) поверхность.

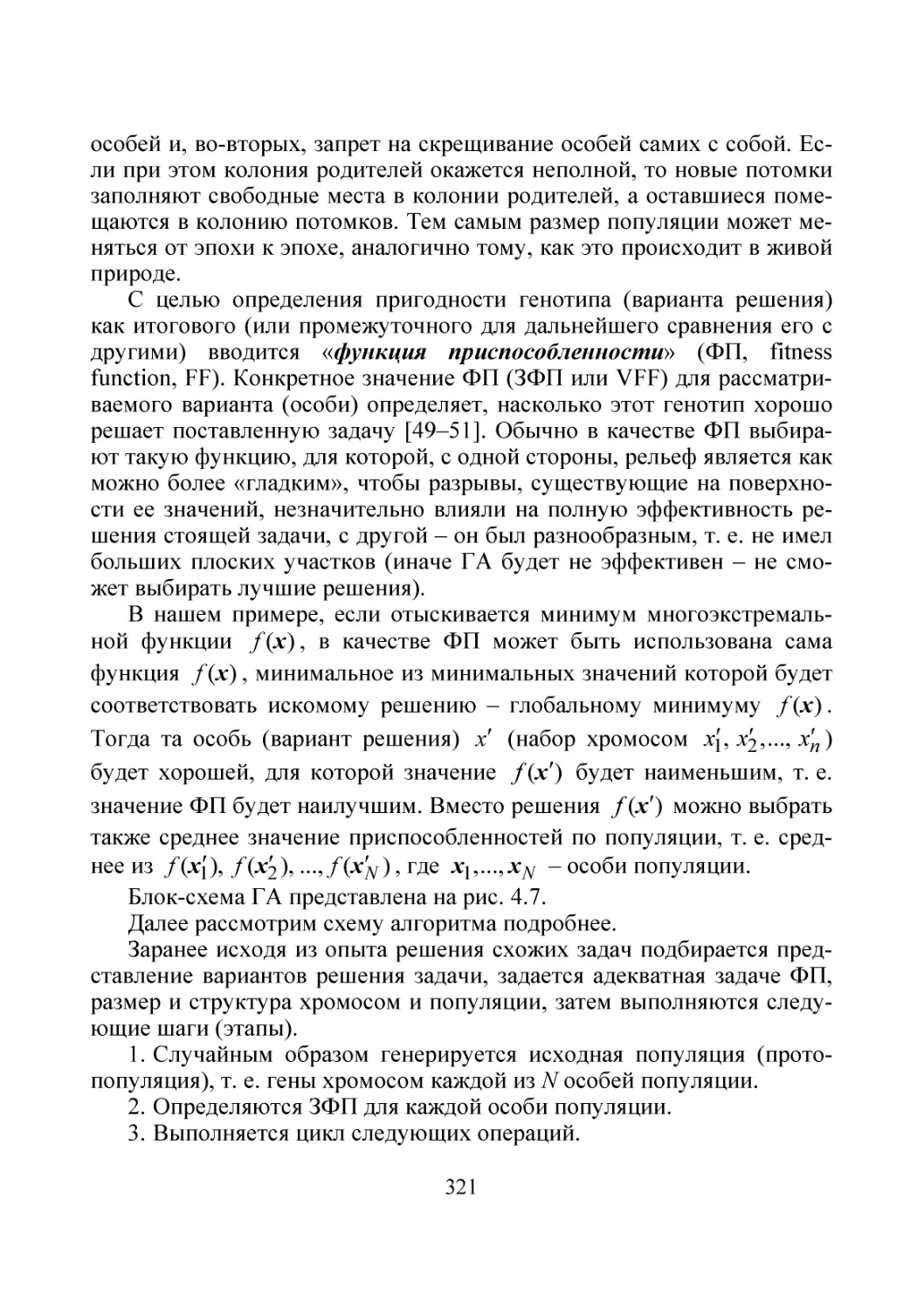

Примеры разделяющих поверхностей приведены на рис. 1.1.

х2

х2

Класс В –

х2

Класс В –

Класс А –

Класс А –

х1

Класс В –

Класс А –

х1

х1

а

б

в

Рис. 1.1. Примеры линейных и ломаных разделяющих поверхностей

классификации объектов на два класса А и В по значениям их двух

признаков х1 и х2:

а, б – непересекаюшиеся реализации классов; в – пересекающиеся

1.2.5. Практические аспекты распознавания образов

Рассмотрим практику решения задач распознавания образов (РО,

классификации, кластеризации). Первый важный прикладной аспект

решения задач РО связан с принципиальной неоднозначностью решения. Это обусловлено тем, что любое модельное представление объектов зависит от цели решения задачи, неоднозначности выбора наилучшего критерия качества результатов решения, числа классов, набора

признаков, выбора метрики и т. п.

Как уже отмечалось, узловым узким моментом, существенно определяющим результаты решения практических задач, является выбор

метрики (меры близости, схожести) между объектами, меры компактности классов1. В каждой конкретной задаче выбор производится по1

Класс называется компактным, если «внутреннее» сходство его объектов

(элементов) друг с другом велико, а «внешнее» сходство объектов других

классов с ними мало [5].

26

своему, исходя из постановки задачи исследования и сопутствующих

ей априорных и апостериорных данных. Различные меры для признаков, измеренных в разных шкалах, можно найти в [2–9].

В частности, для п признаков, измеренных в детерминированных количественных шкалах, принимающих значения x1 , x2 ,..., x N для объекта O и x1, x2 ,..., x N для объекта O , где xi ( x1,i ,..., xn,i ) , используются следующие меры близости (расстояний) (O, O) (сравним с

формулами (4.133), (4.134), приведенными в первой части пособия)1:

обобщенная Евклида (квадратичная)

E (O, O)

N n

k zk ,i zk,i

2

,

(1.1)

i 1 k 1

обобщенная Манхэттена (модулей)

N

M (O, O)

n

k

i 1 k 1

zk ,i zk ,i ,

(1.2)

обобщения Чебышева

Ч (O, O) max k zk ,i zk ,i ,

(1.3)

k

обобщенная Минковского

N n

(O, O) k zk ,i zk ,i

i 1 k 1

1

, 1,

(1.4)

,

(1.5)

Камберра

N n

xk ,i xk ,i

i 1 k 1

xk ,i xk ,i

К (O, O) k

1

В (1.1)–(1.5) предполагается, что значения xk ,i , k 1, n , i 1, N приведены к единому безразмерному стандартному виду. Например, преобразованиями zk ,i xk ,i xk S x , zk ,i ( xk ,i x 0,5 ) ( x0.9,k x0.1,k ) (см. обозначения

в 1-й части пособия). Другие нормировки смотри в начале разд. 4.5.5, часть 1.

27

где k (0,1] – весовые коэффициенты. При k 1 или k 1 N для

всех k 1, n , слово «обобщенная» необходимо опустить.

Особый интерес в последнее время проявляется к различным мерам

компактности классов, представленных признаками в разных измерительных шкалах, мерам близости между предикатами и знаниями,

сходства образов (расстояния между ними), иерархий и т. п. (см.,

например [4, 5]).

Что касается стохастических признаков [9], то для них чаще всего

используются методы типа среднего риска, в частности Байесовского

минимального риска, и апостериорных вероятностей (см. часть 1,

разд. 4.3.7, статистическая проверка гипотез, 4.4.2).

Второй важный аспект практики решения задач исследования

разнообразия объектов (распознавания образов и классификации) сводится к выбору метода и реализующего его алгоритма. Понятно, что

они существенно зависят от постановки задачи, используемых для

представления признаков моделей и измерительных шкал, априорной

информации о них и об объекте, других факторов. С их разновидностями желающие могут познакомиться по специальной литературе

(см., например [3–9]). В последнее время к ранее используемым детерминированным и статистическим методам и алгоритмам построения

моделей разнообразия, основанных на применении линейных,

ломаных (кусочно-линейных) и более сложных разделяющих поверхностей, добавились новые, самообучающиеся, основанные на идеях

интеллекта (генетические, нейронных сетей, роевые и т. п.) (см. главу

4), а также уже упоминавшиеся ранее логические, геометрические

(структурные, включая разделительные и объединительные, графовые,

иерархические) и другие. Они особенно интересны для разделения

объектов по пересекающимся классам, когда один и тот же объект может принадлежать к двум или большему числу классов. Как уже упоминалось, такая ситуация может иметь место априори, когда мал набор

признаков объекта, или апостериори, когда недостаточен объем данных, по которым производится поиск разнообразия либо когда принципиально эмпирические значения признаков попадают в общие зоны

значений признаков объектов из разных классов (как, например, с разными бесконечно протяженными распределениями одной и той же или

разных моделетек (см. далее)).

Для получения представления о методах автоматической (апостериорной статистической) классификации (кластеризации) рассмотрим

два метода кластеризации: k-ближайших соседей и k-средних.

28

Идея метода k-ближайших соседей заключается в том, что тестируемый объект относится к тому классу, который в признаковом пространстве является наиболее распространенным среди заданного числа

соседей этого объекта. Суть метода демонстрирует рис. 1.2.

x2

k=6

k=4

k=3

x1

Рис. 1.2. Пояснение к последовательной

автоматической апостериорной классификации (кластеризации) по методу k-соседей

На рисунке изображено расположение по значениям двух признаков x1 и x2 11 объектов двух классов: квадратов и ромбов, а также тестируемого объекта, изображенного черным кружком, а в качестве

меры расстояния (Oi , O j ) , i, j 1, N принято Евклидово (1.1). Необходимо отнести к классу квадратов или ромбов тестируемый объект O12 ,

изображенный на рисунке кружком. Тогда при k = 3, согласно рассматриваемому методу, тестируемый объект следует отнести к классу

ромбов, так как среди трех его ближайших соседей два ромба и лишь

один квадрат. При k = 6 объект O12 относится к классу квадратов, так

как в круг его ближайших соседей входят четыре квадрата и всего два

ромба. При k = 4 в ближайшие соседи к O12 попадают по два квадрата

и ромба. Правило отнесения объекта O12 к какому-то классу в ситуации равенства количества ближайших к нему соседей оговаривается

отдельно по договоренности, исходя из решаемой прикладной задачи.

Идея метода k-средних заключается в последовательном пошаговом итерационном уточнении так называемых эталонных точек

Э(r ) э1(r ) , э(2r ) ,..., э(kr )

каждого из k непересекающихся классов

29

(k задается априори) с соответствующим пересчетом приписываемых

им весов (r ) 1(r ) , (2r ) ,..., (kr ) на каждом r-м шаге (каждой r-й

итерации).

Рассмотрим эти шаги (итерации).

1. Строится нулевое приближение Э(0) с помощью случайно выбранных k несовпадающих (непересекающихся) точек эмпирического

признакового пространства исследуемой совокупности N объектов (совокупности одновременно полученных значений п признаков для N

объектов, п-размерных элементов N-мерной выборки), т. е. эl(0) xl ,

l(0) 1 , l 1, k .

2. На первой итерации извлекается произвольная точка xk 1 и рассчитывается, к какому из эталонов э(0)

s она оказалась ближе всего.

Этот эталон э(0)

s , самый близкий к xk 1 по принятой мере ,

и его вес заменяются на первой итерации на э(1)

s по правилу: на r-й

итерации э(sr ) l(r 1) эl(r 1) xk r

xk 1 , эl(r 1) min xk r , э(sr 1)

1 s k

l(r 1) 1 ,

и

l(r ) l(r 1) 1 , если

эl(r ) эl(r 1) , а

l(r ) l(r 1) ,

в противном случае, s 1, k .

Если в какой-то r-й итерации обнаружится несколько вдоль s 1, k

одинаковых минимальных значений xk r , э(sr 1) , то отнесение точки xk r к какому-то из таких эталонов определяется по условной договоренности, например, к эталону с минимальным порядковым номером [9].

Далее организуется итерационный процесс поиска кластеров возвращением ко второму шагу первой итерации и продолжением от него

до остановки итерации согласно применяемому критерию.

В качестве критерия остановки итераций обычно выступают следующие.

1. Разделение всего множества из N «тестируемых» (исследуемых)

объектов, т. е. когда кластеры выявлены по всему множеству объектов

и все объекты окажутся распределенными по непересекающимся кластерам.

30

2. Досрочное прекращение итерации на N1-й итерации, когда

N1 N или даже N1 N , если происходит настройка, обучение

«кластеризатора» по следующим обстоятельствам:

когда все возможные кластеры гарантированно удачно определены и это проявляются в том, что при следующих итерациях нет перехода объектов из кластера в кластер;

когда показатель качества кластеризации практически перестает

изменяться.

Поскольку итоги кластеризации зависят от выбора нулевого приближения, т. е. Э0, в ответственных ситуациях при решении особо

важных задач можно рандомизировать процедуру набора Э0 или организовать перебор разных стартовых вариантов Э0.

Третий аспект. Ранее рассматривался подход к исследованию разнообразия объектов, в частности данных, основанный на их модельном

сравнении и разделении исходя из описывающих (представляющих)

объекты (данные) признаков. Иногда такой подход называется

Q-анализом. Возможен и другой подход, когда модели разнообразия

строятся и используются для сравнения и разделения признаков на основе объектов данных (R-анализ объектов, данных), а также смешанный. Желающие могут ознакомиться с такими подходами и сферами

их приложения самостоятельно.

В тех случаях, когда число классов k не задано, а их надо найти по

имеющимся эмпирическим данным, значение k определяется перебором или автоматически. В первом случае выбираем k = 2, затем k = 3 и

так далее, вычисляем для них значение используемого показателя качества кластеризации или решения прикладной задачи и останавливаемся на таком значении k, которому соответствует наилучшее значение

этого показателя. Одна из процедур автоматического выбора k описана

в [9, с. 510, 511].

На рис. 1.3 приведены примеры практического применения метода

k-средних и переборного варианта нахождения наилучшего k для ежесуточных данных по инфекционным заболеваниям, передающимся

преимущественно водным путем, и показателям состояния окружающей среды (водопроводной питьевой воды и воздуха) [10]. Здесь

xk xk xk Sk , xk – эмпирическое среднее арифметическое, Sk –

эмпирическое среднеквадратическое отклонение, сокращение «мутность реки» имеет смысл «мутность воды в реке», а под средним понимается среднее по кластеру значение.

31

32

Процент от квартильного размаха значений

32

Рис. 1.3. Пример результатов кластерного анализа ежедневных данных по состоянию системы «Окружающая среда – Инфекции» в г. Барнауле за 2007–2008 годы

Процент от полного диапазона значений

1.2.5. Заключительные замечания

Первое заключительное замечание связано со следующим.

Ранее по тексту неоднократно упоминалось, что итоги решения задач по разнообразию объектов необходимо оценивать, а меры близости, методы и алгоритмы выбирать с учетом показателей качества результатов. Эти показатели следует разбить на две группы: частные

(локальные) и итоговые (глобальные). Первые ориентированы на определение качества результатов распознавания, классификации или кластеризации как итогов решения именно этих задач, т. е. достижения

локальной цели при исследовании объекта.

Например, как локальные (частные, собственные) показатели

(функционалы) качества разбиения объектов Oi , i 1, N на т кластеров S ( S1 , S2 ,..., Sm ) наиболее часто используются следующие1:

сумма внутриклассных «дисперсий» – средних квадратов расстояний от среднего

вк1 D1 ( S )

m

1

N

j xr S j

j 1

2 xr , x j ,

(1.6)

где N j – число объектов, попавших в кластер S j , N1 N 2 ...

N m N ; x j – среднее арифметическое значение признака х,

найденное по объектам, попавшим в j-й кластер;

сумма попарных внутриклассных расстояний между элементами

вк2 D2 ( S )

m

N

j 1

1

2 ( xr , x p ) ;

(

1)

N

j

j

xr x pS j

(1.7)

мера, основанная на статистике Фишеровского типа

вк3 D3 ( S )

m

2

2 x j , xk D1 ( S ) ,

m(m 1) j k

(1.8)

а также разные меры, основанные на гипотезах компактности [3–9].

1

Как и для мер вк (1.1)–(1.5) при k = 1, деление в (1.6)–(1.8) на число

суммируемых слагаемых N j , N j ( N j 1) , m(m 1) / 2 зачастую не производят.

33

Помимо мер расстояний между разделяемыми по значениям

признаков xi ( x1,i , x2,i , ..., xn,i ) объектов Oi , i 1, N вида (1.1)–(1.8)

вводятся также меры расстояния (близости) между группами (образами, классами, кластерами) ( S j , Sk ) , j , k 1, m объектов. Это особенно

важно в задачах кластеризации. Если xi , как и в мерах (1.1)–(1.8), измеряются в соответствующих шкалах, допускающих приводимые ниже

операции, например в абсолютных количественных, то среди таких

мер наиболее часто употребляются следующие:

расстояние между «ближайшими соседями» рассматриваемых

групп S j , Sk

мк1 min ( S j , Sk ) min ( xr , x p ) ;

xr S j ,

x pSk

(1.9)

расстояние между «дальними соседями»

мк2 max ( S j , S k ) max ( xr , x p ) ;

xr S j ,

x pSk

(1.10)

расстояние между «центрами тяжести» (внутригрупповыми

средними арифметическими x j и xk xk ,1 , xk ,2 , ..., xk ,n групп S j

и Sk )

мк3 ц ( S j , Sk ) ( x j , xk ) .

(1.11)

Наилучшим разбиением S* множества объектов Oi , i 1, N на т*

кластеров считается такое, при котором достигается экстремум (минимум или максимум) соответствующего выбранного функционала

качества.

Именно критерий Фишера – максимум значения статистики Фишера – отношения среднего квадрата межклассовых отклонений (между

центрами (средним арифметическим) кластеров) к среднему квадрату

внутриклассовых отклонений от их центров, характеризующего вариабельность признаков между и внутри кластеров соответственно

(см. (1.8) при E ), был использован в исследованиях, результаты

34

которых представлены на рис. 1.3. Именно по нему было найдено

наилучшее число кластеров, равное четырем. В качестве меры близости при этом использовалось Евклидово расстояние (1.2) между

стандартизованными по правилу xk xk xk S x эмпирическими

значениями признаков xk ,i , k 1, 4 , i 1,365 , где xk – годовое среднее

арифметическое признака xk , S x – годовое эмпирическое среднеквадратическое отклонение. Заметим попутно, что на рис. 1.3 внизу для

сравнения представлены два варианта визуального представления итогов кластеризации: нормированной к размаху выборки (x max x min )

( x( N ) x(1) ) , и к интерквартильной широте | x 0,75 x 0,25 | по каждому признаку.

Еще один показатель качества результатов классификации, кластеризации или распознавания конкретным алгоритмом – вероятность или

частость (частота) правильных ответов на тестовых примерах.

В качестве примера глобального содержательного критерия качества классификации и построения для этого разделяющих поверхностей приведем используемые в медицинской диагностике. Обозначим

через А – количество пациентов с правильно распознанной диагностируемой болезнью (больные распознаны как больные), В – количество

здоровых пациентов, которым ошибочно поставлена болезнь (здоровые не распознаны как здоровые), С – количество пациентов с нераспознанной болезнью (больные, не распознанные как больные) и D –

количество здоровых пациентов, признанных таковыми по отношению

к диагностируемой болезни (здоровые распознаны как здоровые).

Обычно при исследованиях средств и методик диагностик качество оценивается следующими показателями: диагностическая чувствительность

d ч A ( A C ) , диагностическая специфичность dc D / ( B D) и диагностическая точность d т ( A D) / ( A B C D) . Иными словами,

содержательно точность характеризует долю верных диагнозов среди

всех диагнозов, специфичность – среди здоровых пациентов, чувствительность – среди больных пациентов. Понятно, что идеальный случай, когда d т dс d ч 1 . Однако, из-за того что эмпирические данные могут иметь значения, выходящие за пределы нормы допустимых

значений, диагностических признаков и у здоровых, и у больных пациентов как из-за влияния внешних условий, так и из-за чувствительности, информативности используемых диагностических процедур по

35

отношению к диагностируемой болезни, а также из-за погрешности

измерения их значений или по другим причинам, происходит межклассовое пересечение данных, характерных для больных и здоровых

пациентов. Это приводит к тому, что реально эмпирические значения

d т , dс , d ч , как правило, меньше единицы. Поэтому исследователь исходя из стоящей перед ним задачи оценки качества средств диагностики, основанной на решении промежуточной задачи классификации,

дискриминантного анализа, выбирает важный для него критерий:

максимума (равенство или близость к единице) d т , d ч или dс либо

совокупность критериев. Например, руководствуется правилом гипердиагностики: рациональнее часть легкобольных объявить тяжелобольными, нежели сделать противоположную ошибку. Исходя из этого

разделяющая поверхность будет строиться так, чтобы максимизировать какой-то один или два коэффициента за счет двух других или третьего. Локальный показатель качества классификации или построения

разделяющей поверхности, например критерий Фишера, тогда должен

подчиняться этой глобальной оптимизации.

Второе важное замечание касается формального аппарата, используемого для решения задач моделирования разнообразия. Как уже было отмечено, признаки объектов могут измеряться в разных шкалах,

описываться детерминированными, стохастическими, нечеткими,

экспертными моделями, причем точечными или интервальными. Аналогичное можно сказать и о представлении совокупностей групп объектов (образов, классов, кластеров). Оно может быть детерминированным, стохастическим, нечетким, экспертным. В детерминированном

случае принадлежность любого объекта к соответствующей группе

определяется четко через индикаторную функцию, т. е. когда о каждом

объекте группы мы однозначно и четко утверждаем: да, он член

(экземпляр) группы, или нет, т. е. относится к другой группе. В стохастическом делении по группам мы говорим о принадлежности объекта

некоторой группе с определенной вероятностью. При этом вероятность

попадания в некоторое подмножество групп определяется суммой вероятностей попадания в каждую группу, если они не пересекаются,

или как вероятность объединения событий – объединения групп в рассматриваемое подмножество. Ясно, что в том и другом случае вероятность попадания в их полную группу или в любую из групп равна единице. В нечетком описании, во-первых, вместо вероятности попадания

в группу вводится мера принадлежности каждого объекта к соответ36

ствующей группе, во-вторых, состав группы, ее границы могут быть

неопределенными, в-третьих, группы могут не только попарно, но и в

большом количестве пересекаться. Что касается экспертного описания,

то как набор признаков, так и их пороговые значения, разграничивающие группы объектов, определяются экспертным решением и могут

варьироваться в зависимости от состава экспертов, решаемой прикладной задачи и других обстоятельств.

Это же касается и правил принятия решений при отнесении тестируемого объекта к соответствующей группе по эмпирическим значениям его признаков. Здесь ситуация сходна с правилом принятия решений при статистической проверке гипотез (см. часть 1, гл. 4,

разд. 4.3.7). Они могут быть детерминированными, вероятностными,

нечеткими, экспертными, с одной стороны, жесткими или рандомизированными – с другой.

Третье замечание касается того, что задачи моделирования разнообразия объектов могут ставиться как оптимизационные (см. часть 1,

гл. 4). Например, при кластерном анализе можно поставить задачу

нахождения оптимума числа кластеров с точки зрения локального или

глобального критерия качества решения задачи исследователя, оптимизации числа итераций по выделению кластеров и т. д. Желающие

могут познакомиться с такими постановками самостоятельно или

предложить свои.

Наконец, четвертое замечание. Одним из важнейших критериев

качества кластеризации может служить качественный или количественный показатель ее естественности, т. е. способности выявить при

кластеризации действительные, существующие на самом деле, классы

паттернов, четко отделяемые друг от друга любым методом, исследователем. Тогда, с одной стороны, критерием естественности классификации можно выбрать степень устойчивости, достоверности результатов кластеризации к замене используемых методов (алгоритмов),

с другой – считать лучшим, более близким к качественным, тот метод,

который дает лучшие показатели устойчивости на различных тестовых

задачах, с разными сопутствующими кластеризации условиями получения и качества данных. Более естественным может оказаться метод,

основанный на одновременном применении комбинации нескольких

разных методов (см. часть 2, гл. 4, вариативное моделирование).

Обобщенная схема технологического процесса решения задач

моделирования разнообразия объектов представлена на рис. 1.4 (ср.

с рис. 2.3, 3.10–3.13, 4.9, 4.19, 4.21, см. часть 1).

37

1. Глобальная постановка задачи прикладного исследования

(формулировка цели, перечня задач, назначение

глобального скалярного или векторного критерия качества

желаемого результата)

2. Совместный анализ постановки задачи прикладным

исследователем и специалистом по моделированию разнообразия

(по куализному моделированию) объектов

3. Совместная вербальная постановка локальной задачи

распознавания образов, классификации или кластеризации,

признаковое описание объектов исследования

(вид задач уточняется совместно)

4. Формализация постановки локальной задачи

(включая выбор или разработку частных критериев качества

результатов, метрик, измерительных шкал, метода и алгоритма

и т. п. (по необходимости))

5. Получение, корректировка, приведение к принятому стандарту

эмпирических значений разных признаков, разведочный анализ,

предварительный анализ признаков, минимизация признакового

пространства и т. п. (по мере необходимости)

6. Ручная, автоматизированная или автоматическая реализация

алгоритма распознавания, классификации или кластеризации

(в соответствии с результатами выполнения этапов 1–5).

Внутренняя проверка качества результатов.

Возврат к соответствующему этапу 1–5 по мере надобности

Апробация полученных результатов на прикладных задачах,

возврат на соответствующий этап по мере необходимости

Документальное оформление результатов, формирование

постановок новых задач для исследователей и специалистов

по моделированию

Рис. 1.4. Укрупненная схема технологического

процесса моделирования разнообразия объектов

38

§ 1.3. МОДЕЛИ СТРУКТУР ОБЪЕКТОВ

И СВЯЗНОСТИ ИХ ЭЛЕМЕНТОВ.

ЭЛЕМЕНТЫ ТЕОРИИ ГРАФОВ И СЕТЕЙ

1.3.1. Основные понятия

Помимо моделей разнообразия объектов к куализным можно отнести модели, предназначенные для описания структур объектов, их

топологий, состава и связей элементов в объекте.

Среди этих моделей такие, которые представляются в виде блок-,

структурных, функциональных, различных эквивалентных схем. С подобными моделями, в частности с блок-схемами алгоритмов и программ, читатель наверняка уже неоднократно сталкивался.

Особый интерес в различных разделах информатики имеют представления структур объектов (особенно разнообразных систем) в виде

графов [11–16]. Идея такого описания очень проста: представлять важные для исследования объекта составляющие его элементы в виде

вершин графа, а связи между ними – в виде ребер графа. Либо, наоборот, элементам объекта можно поставить в соответствие ребра, а связям – вершины. Такие графы называются реберными. И в том и в другом случае работа с такими моделями осуществляется согласно теории

графов. Рассмотрим основные ее понятия.

Граф G (V , ) – это множество V объектов x, y, z , v V , называемых вершинами, и любая совокупность неупорядоченных, называемых ребрами, и упорядоченных, называемых дугами, пар

( x, y ) этих объектов (вершин) x и y1.

Говорят, ребро ( x, y ) или (v, z ) соединяет вершины x и y либо v и z, а дуга ( x, y ) либо (v, z ) начинается в вершине x (либо v)

и заканчивается в вершине y (либо z)2. Графически вершины отображаются точками (кружками, шарами), ребра (v, z ) отображаются линиями (отрезками), соединяющими точки v и z, а дуги (v, z ) –

1

Для удобства вершины, т. е. элементы множества V, будем обозначать

латинскими буквами x, y, u , v, z , а ребра (дуги), т. е. элементы множества ,

греческими , , , , ,... .

2

Поскольку дуги есть направленные ребра, всюду, где это не может вызвать недоразумения, будем вместо сочетания «ребра (дуги)» писать просто

ребра.

39

стрелкой, направленной от точки v к точке z. Граф, содержащий только

ребра, называется неориентированным, а только однонаправленные