Текст

А. П. ЕРШОВ

ВВЕДЕНИЕ

В ТЕОРЕТИЧЕСКОЕ

ПРОГРАММИРОВАНИЕ

БЕСЕДЫ О МЕТОДЕ

Допущено Министерством

высшего и среднего специального образования СССР

в качестве учебного пособия

для студентов вузов, обучающихся

по специальности «Прикладная математика»

ИЗДАТЕЛЬСТВО «НАУКА»

ГЛАВНАЯ РЕДАКЦИЯ

ФИЗИКО-МАТЕМАТИЧЕСКОЙ ЛИТЕРАТУРЫ

МОСКВА 1977

518

E80

УДК 519.95

Введение в теоретическое программирование (беседы о

методе). А. П. Ершов. Главная редакция

физико-математической литературы изд-ва «Наука», М., 1977.

Книга представляет собой цикл лекций, написанных в виде

беседы с читателем. Подробно рассматриваются две,

классические задачи теоретического "программирования, решения

которых и развитые на этих решениях методы привели к созданию

теоретического программирования как самостоятельной

математической дисциплины. Это — задача экономии памяти в

схемах Лаврова и задача построения полной системы

преобразований в схемах Янова.

Книга рассчитана на студентов вузов.

Андрей Петрович Ершов

ВВЕДЕНИЕ В ТЕОРЕТИЧЕСКОЕ ПРОГРАММИРОВАНИЕ

(беседы о методе)

М., 1977 г., 288 стр. с илл.

Редактор Г. Я. Пирогова

Технический редактор Е. В. Морозова

Корректор Т. С. Вайсберг

Сдано в набор 15.07.1977 г. Подписано к печати 17.11.1977 г.

Бумага 60χ907ιβ. Физ. печ. л. 18. Условн. печ. л. 18.

Уч.-изд. л. 18,48. Тираж 55 000 экз. Т-207И.

Цена книги 80 коп. Заказ № 620.

Издательство «Наука»

Главная редакция физико-математической литературы

11701, Москва, В-71, Ленинский проспект, 15

4-я типография изд-ва «Наука», 630077, Новосибирск, 77,

Станиславского, 25

ρ 20204 — ШПо по о» 77 (©Главная редакция

Пго/по\ пп "в-оо-01 — ι/ ν^физико-математической ллтератуиь»

VOQ(02)-77 издательства «Наука», 1977

ОГЛАВЛЕНИЕ

Предисловие 5

Часть I

ЭКОНОМИЯ ПАМЯТИ В ОПЕРАТОРНЫХ СХЕМАХ

Г л а в а 1. Содержательный анализ задачи 9

§1.1. Краткое повторение программирования 9

§ 1.2. Накопление фактов. Линейные программы 14

§ 1.3. Накопление фактов. Программы общего вида ч 29

§ 1.4. Накопление фактов. Подведение итогов 43

Глава 2. Постановка задачи и общая теория 52

§ 2.1. Краткое повторение математических основ 52

§ 2.2. Исходные определения 62

§ 2.3. Общая теория . . « ♦ 83

Глава 3. Алгоритмизация ♦ « 90

§ 3.1. Информационный граф 90

§ 3.2. Граф несовместимости 99

§ 3.3. Раскраска вершин графа. Общее исследование 110

§ 3.4. Раскраска вершин графа. Поиск алгоритма 128

Глава 4. Реализация 143

§ 4.1. Вступление 143

§ 4.2. Структурированное программирование 145

§ 4.3. Общая организация экономии памяти 151

§ 4.4. Каноническое распределение памяти 153

§ 1.5. Получение графа несовместимости 160

§ 4.6. Раскраска вершин графа 164

Глава 5. Заключительный анализ 168

§ 5.1. Связке теорией и практикой 168

§ 5.2. Исторический обзор 179

Часть II

ПРЕОБРАЗОВАНИЯ СХЕМ ЯНОВА

Глава 6. Краткое повторение математической логики 189

§ 6.1. Логические формулы и булевы функции 189

§ 6.2. Алгебра логики 200

§ 6.3. Исчисление высказываний 210

4

ОГЛАВЛЕНИЕ

Глава 7. Определение схем Янова 22$

§ 7.1. Начальные наблюдения 226

§ 7.2. Поиск основных определений 239>

§ 7.3. Эквивалентность схем Янова 245

Глава 8. Исчисление равносильных преобразований 254

§ 8.1. Построение исчисления 254

§ 8.2. Корректность исчисления 265

§ 8.3. Канонические схемы и технические теоремы 270

$ 8.4. Полиота исчисления 276

§ 8.5. Еще один исторический обзор 281

Указатель терминов 287

ПРЕДИСЛОВИЕ

Для автора эта книга носит экспериментальный характер.

Положительным исходом этого эксперимента будет заполнение

некоторого пробела в математической литературе. Насколько,

однако, актуально заполнение этого пробела, покажет время,

а пока автор постарается объяснить предпосылки своего

эксперимента.

Книга адресована в первую очередь тем, кто изучает

математику. Целью математического образования является получение

математических знаний и выработка умения применять эти

знания либо в решении прикладных задач, либо в строительстве и

перестройке самого постоянно развивающегося здания математики.

К сожалению, в той части математического образования, которая

оцределяется учебными планами и обязательными занятиями,

имеет место заметный разрыв между его информационным и

творческим компонентами. В значительной степени этот разрыв

неизбежен. Большой объем накопленных знаний, впрессованный

в учебник или лекционный курс, просто не оставляет времени и

места для познания природы и объема творческих усилий,

затраченных на добывание этих знаний. Безупречная логика в

организации лекционного материала, совершенство в его подаче

делают для слушателей незаметными швы и элементы

конструкций, создают у студентов ощущение незыблемости идеального;

они чувствуют себя скорее посетителями храма науки, нежели его

обитателями и тем более строителями. Разделы учебного плана,

требующие активной работы студентов (упражнения,

практикумы) ^часто носят тренировочный, целевой характер, при

котором отсутствует элемент постановки задачи или поиска метода

решения, столь необходимый для развития творческого

воображения.

Общеизвестно, что именно первые три года учебы в вузе

являются решающими для формирования профессионального, а

зачастую и общего мировоззрения студента. Работа на последних

двух курсах носит уже более прагматический, целеустремленный

характер. Поэтому так актуальна задача раннего приобщения

студентов к творческому началу в выбранной ими

специальности. В математическом образовании дополнительной трудностыр

б

ПРЕДИСЛОВИЕ

является то,что большинство ныне развивающихся разделов

математики весьма неэлементарны и не могут быть предметом изучения

на младших курсах.

Сказанное выше послужило основой для отбора материала и

способа его изложения в этой книге.

Теоретическое программирование (называемое также в ряде

переводных работ теоретической вычислительной наукой или

математической теорией вычислений) — это новый раздел

математической науки, чьим объектом изучения являются

математические абстракции программ — предписаний, выраженных на

специальных алгоритмических языках, обладающих определенной

информационной и логической структурой и подлежащих

выполнению на автоматических вычислительных машинах. Родившись

частично из практических потребностей, частично из желания

познать природу новых явлений, вызванных электронными

вычислительными машинами (ЭВМ), теоретическое

программирование, освоив средства и понятия фундаментальных математических

дисциплин — логики, теории алгоритмов, алгебры ж

комбинаторики, начинает в дополнение к этому постепенно формировать

собственный круг понятий и методов. Рассказать о некоторых

из них — одна из задач книги, хотя и не главная.

Главная цель книги — на примере подробного рассмотрения

двух задач, решение которых сыграло очень важную роль в

появлении теоретического программирования как предмета,

объяснить ход мысли при решении этих задач, продемонстрировать

математический метод мышления в действии, внимательно

проанализировать этапы содержательного анализа и постановки

задачи, раскрыть эстетическую компоненту в пояске решения,

другими словами, сделать читателя активным свидетелем процесса

получения математического результата. Эта цель предопределила

форму изложения: книга написана в виде беседы с читателем и

предназначена больше для чтения, нежели изучения.

В первой части рассматривается задача экономии памяти

в операторных схемах программ. Конструкции и понятия,

вошедшие в теоретическое программирование в связи с решением этой

задачи, не только внесли существенный вклад в развитие

предмета, но и стали основой широкого класса преобразований

программ, применяемых в системах автоматизации программирования

и при проверке правильности программ. Задача экономии памяти

рассматривается как пример решения прикладной задачи с

применением математических методов. Изложение разбито на главы,

в каждой из которых анализируется один из неотъемлемых этапов

полного решения прикладной задачи: содержательная постановка

задачи, точная постановка и общая теория, поиски

конструктивного метода решения, затем его алгоритмизация и, наконец,

составление программ на алгоритмическом язык§>

ПРЕДИСЛОВИЕ

7

Во второй части излагается теория операторных схем Янова —

классическая работа, общепризнано послужившая началом

математической теории программирования. В созданной А. А.

Ляпуновым и Ю. И. Яновым модели программ последний разработал

формальное исчисление, в котором полиостью решалась задача

распознавания эквивалентности моделей программ и строилась

система независимых преобразований программы в любую, ей

эквивалентную. Теория операторных схем Янова разбирается

в этой книге как методологический пример распространения

развитой математической теории (в данном случае формального

исчисления высказываний) на новый класс явлений и объектов —

операторных схем и их конфигураций.

Еще несколько слов в обоснование предмета изложения.

Как известно, программирование сейчас становится массовой

профессией. К сожалению, как в преподавании

программирования, так и в его повседневной практике зачастую преобладает

поверхностный, рецептурный подход к его изучению и

применению, при котором элементарная грамотность во владении

алгоритмическими языками представляется чуть ли не

исчерпывающим содержанием профессии. Разрыв между высоким

математическим зарядом, получаемым математиками-программистами,

и обыденностью рутинной работы по составлению программ

создает у некоторых ощущение девальвации их математической

квалификации при занятии программированием. Автор надеется,

что содержание этой книги поможет практикующим

программистам увидеть точки приложения математических методов к

объектам и содержанию их деятельности.

Другой «удобной» чертой теоретического программирования

является то, что эта наука рождается у нас на глазах. Это

позволяет более живо и достоверно проследить механизм добывания

научных результатов и этапы развития предмета. Одним из

признаков молодости науки является преобладание прямых методов

доказательств и элементарности постановки многих задач. Это

также делает изложение более живым, непосредственным и не

требующим высокого порога предварительного знания. Наконец,

последним по счету, но не по важности соображением является то,

что эта область совпадает с конкретными научными интересами

автора, что дает ему возможность излагать материал, полученный

из первых рук.

Элементарность изложения позволила сделать содержание

книги замкнутым и не требующим обязательного

предварительного чтения других работ. Тот минимум начального знания, которое

все же считается полезным или необходимым, перечисляется или

кратко излагается в повторительных параграфах, вставленных

в нужных местах. Говоря об элементарности изложения, автор

все же должен предупредить читателя, что возможность постигать

8

ПРЕДИСЛОВИЕ

содержание книги в темпе чтения будет требовать от него

постоянной концентрации внимания и работы мысли. Не ощущая вначале

никакого порога и следуя 'линии изложения, читатель тем не

менее к концу книги окажется на высоте проблематики, которая

является содержанием современной профессиональной

математической работы, не делающей никаких скидок на возраст и опыт

читателя.

Как уже было сказано, книга в основном предназначена для

самостоятельного чтения университетскими студентами. Она

может быть также использована для кружковой или просеминарской

работы в техникумах, физико-математических классах и на

младших курсах пединститутов.

Материал книги складывался в течение нескольких лет и был

частично апробирован в летней школе вузовских преподавателей

Дальнего Востока (Владивосток, 1970 г.), в курсе лекций,

прочитанных в Стэнфордском университете (1970 г.), и спецкурса

для студентов-математиков младших курсов в Новосибирском

университете (1971/72 уч. год).

Подчеркивая экспериментальный характер этой книги, автор

все же не может не назвать некоторые выдающиеся

математические сочинения, воодушевлявшие его во время работы над книгой.

Надо полагать, многие современные математики испытали на себе

воздействие таких замечательных книг, как «Что такое

математика?» Куранта и Робинса и «Математика и правдоподобные

рассуждения» Пойя. Что каеаётся более избирательного влияния,

то в свое время на автора произвели сильное впечатление

небольшая книга Хинчина «Три жемчужины теории чисел» как

непревзойденный пример раскрытия содержания науки через

обсуждение конкретных задач, и известный, мемуар Бэра «О разрывных

функциях», убедительно демонстрирующий силу поступательного

развития решения задачи, начиная с элементарной постановки

и кончая полным решением проблемы во всей ее сложности.

Будучи далеким от мысли поставить себя в ряд со столь

знаменитыми предшественниками, автор тем не менее видит в своем

труде скромную попытку частичного осуществления долга,

оставленного нам учителями, — не жалеть усилий на раскрытие пользы,

глубины и красоты математической науки перед лицом каждого,

желающего приобщиться к этому фундаменту современного

знания.

Новосибирск, Академгородок

А. П. Ершов

ЧАСТЬ I

ЭКОНОМИЯ ПАМЯТИ В ОПЕРАТОРНЫХ СХЕМАХ

ГЛАВ А 1

СОДЕРЖАТЕЛЬНЫЙ АНАЛИЗ ЗАДАЧИ

§ 1.1. Краткое повторение программирования

Электронная вычислительная машина. ЭВМ — это автомат,

состоящий из памяти и исполнительного устройства. Память

состоит из занумерованных подряд ячеек. Номер ячейки

называется ее адресом. В ячейках памяти хранится информация,

представленная в машине в виде двоичного числа, т. е.

последовательности нулей и единиц. Как и в обычной арифметике, позиции

двоичных цифр содержимого ячейки называют разрядами.

Подобно тому как в азбуке Морзе последовательности точек и тире

могут обозначать самую разную информацию, так и нули и

единицы в ячейках памяти могут иметь смысл не только двоичных

разрядов числа, но и многого" другого. Для того чтобы

подчеркнуть возможность самой разной интерпретации содержимого

ячеек памяти, это содержимое называют (машинным) словом.

Число двоичных разрядов в слове называется его длиной.

Исполнительное устройство может выполнять отдельные

команды. Набор разных команд (система команд ЭВМ), которые может

выполнять устройство, обычно сравнительно невелик, а сами команды

очень просты. Типичной командой *является следующая: взять из

указанных ячеек памяти одно или два слова в качестве аргументов,

передать их в исполнительное устройство, выполнить над ними

указанное действие (сложить, умножить, сравнить по величине

и т. п.), а результат направить в указанную ячейку памяти.

Программа. Из сказанного понятно, что для решения сколько-

нибудь сложной задачи ЭВМ должна выполнить очень длинную

последовательность команд. Так как ЭВМ работает автоматически,

' то эта последовательность команд должна быть придумана заранее

и введена в память машины до начала решения задачи. Обычно

в одной ячейке памяти хранится точно одна команда машины,

а непрерывность работы исполнительного устройства

обеспечивается тем, что каждая команда (если только это не была команда

остановки машины) обязательно оставляет в исполнительном

устройстве адрес ячейки со следующей подлежащей выполнению

командой. Таким образом, составить программу решения задачи

на ЭВМ — это значит написать такую последовательность команд

машины, чтобы они, оказавшись в нужной части памяти машины

10

ГЛ. 1. СОДЕРЖАТЕЛЬНЫЙ АНАЛИЗ ЗАДАЧИ

и выполняясь одна за другой, создали бы последовательность

действий исполнительного устройства, которая приведет к

решению задачи.

Каждая команда программы заставляет выполнить указанное

в ней действие с содержимым указанных ячеек памяти. Это значит,

что при составлении программы нужно определить, какие ячейки

памяти будут использованы в работе машины и что в них будет

храниться. Обычно поступают таким образом. Размышляя над

способом решения задачи, программист определяет, какие

переменные величины появляются и используются при ее решении.

Одни величины даются уже в условии задачи — обычно это ее

исходные данные и искомые результаты. Другие возникают в ходе

решения задачи и называются промежуточными переменными

величинами. Их значения вычисляются как результаты

выполнения одних команд программы и используются позднее в других

командах как их аргументы.

Таким образом, при составлении программы у программиста

появляется два списка — список команд и список величин

программы. Эти списки непосредственно связаны с памятью машины

(каждой позиции каждого из списков сопоставляется некоторая

ячейка) и друг с другом. Связи величин с командами выглядят

следующим образом. Каждая команда состоит из двух частей:

кода операции, который указывает, какое действие вызывает

команда, и адресной части. В адресной части указаны адреса

ячеек, используемых в качестве аргументов и результатов

команды. В некоторых командах в адресной части указываются

не ячейки с величинами программы, а адреса команд,— в

частности, когда следующая по порядку выполнения команда

находится в программе не вслед за данной, а где-то в другом месте,

которое и указывается своим адресом. Это случается, например,

при необходимости повторить группу команд программы

несколько раз или выбрать один из нескольких вариантов вычислений

в зависимости от значения переменных величин программы.

Программирование. Осмысливая только что прочитанное, мы

можем усмотреть некоторое сходство программирования для ЭВМ

со школьным способом решения арифметических задач по

вопросам. Решая задачу таким способом, ученик должен был составить*

план решения в виде серии вопросов. В вопросе спрашивалось,

какая величина задачи должна быть вычислена. Вопрос ставился

так, чтобы это вычисление выполнялось за одно действие над уже

известными величинами. Пределом трудности считалась задача,

которая решалась в 5 — 6 действий. Программирование же для

ЭВМ реальных задач требует предусматривать в плане решения

десятки тысяч и большее количество действий, для каждого из

которых должна быть безошибочно записана вызывающая его

команда. Поэтому с самого начала появления ЭВМ все усилия

§ 1.1. КРАТКОЕ ПОВТОРЕНИЕ ПРОГРАММИРОВАНИЯ Ц

программистов были направлены на создание методов облегчения

задачи программирования.

Один из таких методов состоит в том, что составление

программы для ЭВМ разбивается на этапы. На одном этапе программист

составляет программу в такой форме, в которой ему легче эту

программу придумать. На другом этапе промежуточная форма

программы по некоторым формальным правилам превращается

в программу, непосредственно воспринимаемую машиной

(машинную программу). Формальными эти правила являются в том

смысле, что их применение к промежуточной форме требует

педантичной точности, но не требует понимания того, что делает

программа. Другими словами, эти правила единым образом

применимы к любой промежуточной форме программы. Последнее

обстоятельство позволяет правила перевода промежуточной

формы программы в машинную описать в виде общего алгоритма.

Этот алгоритм можно в свою очередь запрограммировать. У

получившейся таким образом «сверхпрограммы» входными данными

будет любая промежуточная форма программы, а результатом —

машинная программа, в точности соответствующая

промежуточной форме. В специальной литературе такие «сверхпрограммы»-

переводчики называются трансляторами, компиляторами или

программирующими программами. При наличии транслятора

промежуточная форма программы, бдлее удобная для ее

составления человеком, становится для него окончательной формойг

а всю остальную работу по освоению программы машина с

помощью транслятора берет на себя.

Таким образом, задача программирования как

научно-технической дисциплины состоит в том, чтобы разрабатывать «языки

программирования» — способы выражения программ, удобные

для человека, и методы трансляции, перевода с языков

программирования на то, что можно назвать языком машины или

машинным языком.

Символическая программа. Простейшая помощь программисту

состоит в том, чтобы предоставить ему возможность составлять

вместо машинной так называемую символическую программу.

Символическую программу программист придумывает, тоже держа

в голове систему команд ЭВМ. Он по-прежнему должен написать

список команд и список величин программы так, чтобы каждая

позиция в этих списках соответствовала одной ячейке памяти

машины. Однако способ записи этих списков более удобен для

программиста. Вхместо адресов ячеек памяти для величин

программы он может использовать те естественные обозначения, которые

эти величины имели в условии задачи, или те, которые он сам

придумает для большей наглядности. Вместо числового кода

операции, изображаемого в машинной команде комбинацией

двоичных цифр, программист может использовать так называемый

12

ГЛ. 1. СОДЕРЖАТЕЛЬНЫЙ АНАЛИЗ ЗАДАЧИ

мнемонический код (мнемокод), который своим видом подсказывает

ему содержательный смысл команды: например, + для команды

сложения, ^ для команды сравнения чисел, или слово СТОП

для команды остановки машины. Если программисту нужно

употребить адрес команды, он помещает в символической

программе против этой команды любое подходящее по смыслу слово

или букву, которая называется меткой команды, и употребляет

в адресной части эту метку в качестве адреса команды.

Для обозначений величин, мнемокодов и меток программист

может использовать любые символы, буквы и цифры, лишь бы

получающийся текст символической программы годился для

ввода в ЭВМ. В первом приближении достаточно сказать, что

в ЭВМ можно ввести любой текст, который может быть напечатан

на пишущей машинке без особых ухищрений, т. е. без выхода

за основную строку, без подчеркиваний и надпечаток.

Преобразование или, как принято говорить, трансляция

символической программы в машинную происходит следующим

образом. Сначала ЭВМ под управлением транслятора

воспринимает символическую программу. Затем машина составляет таблицу

обозначений и меток, использованных в программе. Таблицу

мнемокодов машине составлять не надо, так как она одна и та же

для всех символических программ и хранится в трансляторе

постоянно. После этого происходит распределение памяти, т. е.

сопоставление каждой величине и каждой команде программы

той ячейки памяти, в которой эта величина или команда

будет находиться. Заметим, что память можно распределять

тривиально:

а) для команд: размещать команды машинной программы

в точности так, как они размещены в символической программе.

Тогда достаточно посчитать число команд в программе, отметить

в памяти машины такое же количество ячеек, начинающихся

с некоторого адреса А, и сопоставить п-& по порядку команде

ячейку с адресом А + η — 1;

б) для величин: каждую величину помещать в отдельную

ячейку; всего будет занято столько ячеек памяти, сколько

обозначений величин использовано в символической программе.

После распределения памяти остается систематически в

каждой команде символической программы заменить мнемокод

операции на двоичный код, а обозначения величин и метки команд

в адресных частях команд — на сопоставленные им адреса

ячеек.

Алгоритмический язык. Следующим серьезным шагом в

сторону облегчения работы программиста является программирование

на алгоритмических языках.

Программа на алгоритмическом языке тоже состоит из списка

команд и списка величин программы. Однако эти команды на-

§ 1.1. КРАТКОЕ ПОВТОРЕНИЕ ПРОГРАММИРОВАНИЯ 13

столько не похожи на команды машины, что они даже и

называются по-другому — операторами. Величины программы тоже могут

не иметь прямого отношения к ячейкам памяти машины.

Например, программист может использовать в программе комплексные

числа и не заставлять себя каждый раз вспоминать, как они

изображаются в памяти машины.

Основным оператором алгоритмических языков является

вычисление по формуле. Вычисленное значение может быть

присвоено переменной величине или использовано каким-либо другим

образом, разрешаемым правилами языка. Операции,

используемые в формулах, являются либо общеизвестными

математическими операциями и функциями, либо объясняются правилами

языка, либо придумываются самим программистом. Естественно,

что в последнем случае программист должен с помощью

подходящей ^вычислительной процедуры «описать», как выполняется

соответствующая операция или функция.

Формулы в алгоритмических языках называются выражениями,

а соответствующие операторы — операторами присваивания, или

арифметическими операторами.

Кроме указанных операторов, в алгоритмических языках

используются своего рода «организующие» операторы, которые

не столько вычисляют, сколько определяют порядок вычислений.

К ним относятся условные операторы, которые выбирают тот или

иной вариант вычислений, в зависимости от проверки некоторого

условия, и операторы цикла, которые организуют повторение

некоторых вычислений нужное число раз.

Наконец, программы на алгоритмических языках не

записываются в жестком табличном формате, как машинные и

символические программы, а имеют фразовую структуру, к тому же

использующую, правда, в сравнительно ограниченных пределах, такие

общепонятные слова (или их сокращения), как начало, конец,

целый, вещественный, цикл, процедура, если, то, иначе и т. п.

Все это вместе взятое приближает алгоритмические языки как

к естественным человеческим языкам, так и к общепринятой

математической символике.

Алгол. В нашей книге мы буцем повсеместно использовать

один из наиболее распространенных алгоритмических языков —

алгол-60. Для начинающих читателей можно мимоходом заметить,

что говорить «алгоритмический язык алгол» — это, примерно,

то же самое, что говорить «черные чернила», так как оригинальное

название языка ALGOL есть сокращение от ALGOrithmic

Language, что является английским эквивалентом «алгоритмического

языка». Если же указанную категорию читателей больше

беспокоит то, что им еще не представился случай познакомиться

с этим языком, то им автор рекомендует для предварительного

чтения книгу А. Л. Брудно, Алгол, М., «Наука», 1971.

14

ГЛ. 1. СОДЕРЖАТЕЛЬНЫЙ АНАЛИЗ ЗАДАЧИ

Трансляция программ, составленных на алгоритмическом

языке, в машинные уже существенно более сложна, чем в случае

символических программ. Минимальная работа состоит в

следующем. Транслятор тоже начинает с того, что составляет таблицу

символических имен, использованных в программе для величин

программы, меток операторов и функций, придуманных

программистом. После этого формулы, использованные в записи

программы, расчленяются на отдельные операции и функции. При этом

в программе появляются новые промежуточные величины.

Обозначения функций, введенных программистом, заменяются

ссылками на вычисляющие их процедуры. После этого каждая

элементарная операция или функция, упоминаемая в программе,

заменяется последовательностью машинных команд, которые, как

принято говорить, реализуют эту операцию или функцию. Это же

происходит и с «организационными» условными операторами и

операторами цикла. Соответствие между элехментарными

действиями, функциями и операторами алгоритмического языка и

реализующими их «кусочками» машинной программы является

постоянным и закладывается в транслятор.

В результате сборки этих «кусочков» получается символическая

программа, для которой затем производится уже упоминавшееся

нами распределение памяти. Именно этот процесс распределения

памяти и будет для нас главным предметом обсуждения в первой

части книги.

Прежде чем приступить к делу, сделаем, однако, одно

техническое замечание. Пусть программа на алгоритмическом языка

написана так, что каждый оператор в ней содержит только одну

операцию. Тогда, если операция алгоритмического языка можег

быть выполнена одной командой ЭВМ, а каждая величина

программы может поместиться в одной ячейке памяти, то соответствие

между программой на алгоритмическом языке и реализующей ее

символической програмх\юй становится буквальным: отличие

между ними только в способе записи. Это позволит нам в книге

пользоваться только алголом, даже если мы будем работать с

примерами, по своей детальности приближающемся к символическим

программам.

§ 1.2. Накопление фактов. Линейные программы

Простейшие примеры. Вообразим себя начинающими програм-.

мистами, которым надо вычислить на ЭВМ у = я7, не используя

операцию возведения в степень.

Прочитав повторительный параграф по программированию,

воспользовавшись нужными правилами алгола и мобилизовав,

школьный опыт решения задач по вопросам, мы можем

написать следующую программу:

§ 1.2. НАКОПЛЕНИЕ ФАКТОВ. ЛИНЕЙНЫЕ ПРОГРАММЫ

Д5

Ή ρ и м е ρ 1. Вычислить х1.

начало вещ х, у, х2, хЪ> х4, хЪ, #6;

ввод (х);

х2: =

хЗ :==

xi : =

хЪ : =

хб : =

»: =

вывод (у)

X

х2

хЪ

х4

хЪ

xQ

X

X

X

X

X

X

х\

X]

х\

х\

х\

х;

Однако не менее вероятно, что программа будет выглядеть

также и следующим образом:

Пример 2. Вычислить х1.

начало вещ х, у;

ввод (х);

У

У

У

11

У

У

вывод ([

конец

, — X /\ Х'у

= У X х\

= у X х;

= у х χ;

= У х х\

= у х *;

/)

Эти два простейших примера уже дают нам пищу для

размышления. Во-первых, мы видим, что обе программы решают

нашу задачу. Во-вторых, вторая программа гораздо лучше первой:

она требует только двух ячеек памяти, в ней пять последних

команд одинаковы, и это наталкивает нас па еще большее

сокращение программы, если заставить (с помощью оператора цикла)

один оператор у: = у Χ χ повториться пять раз:

Пример 3. Вычислить х7.

начало вещ х, у; цел i\

ввод (х);

у : = χ Χ х\

для i : = 1 шаг 1 до 5 цикл у := у χ χ;

вывод (у)

конец

Первый вывод. Задача может быть запрограммирована

разными способами: одни способы лучше, другие хуже.

16

ГЛ. 1. СОДЕРЖАТЕЛЬНЫЙ АНАЛИЗ ЗАДАЧИ

Второй вывод. Программы могут отличаться друг от

друга сильнее и слабее: первая и вторая программы больше

похожи друг на друга, нежели каждая из них на третью.

Третий вывод. Первые две программы настолько

похожи, что даже лучше говорить, что это одна и та же лрограмма,

только с разными обозначениями для промежуточных величин —

в первой программе они все разные, а во второй одни и те же.

Четвертый вывод. Имеет смысл такая проблема:

составить программу, используя наименьшее количество

обозначений для величин. Это приводит к экономии памяти.

Следует заметить, однако, что все эти выводы носят чисто

наблюдательный характер. Автору первой программы не мешало бы

спросить у своего коллеги, составившего вторую программу:

«А как ты додумался весь счет вести через ι/?» Если второй автор

не глуп, он не выразит недоумения, а, подумав, ответит: «Как

только у умножается на х, он мне уже не нужен, и поэтому я могу

это произведение направить туда же». В свою очередь первый

автор, чтобы оправдать свой подход, скажет: «Но ведь у меня

программа логичнее: χ в пятой степени, например, никогда не будет

равен χ в третьей, вот я их и обозначил по-разному». Второй

заметит: «Но зато я зациклил и тем самым сократил свою

программу»,— и покажет первому третий пример.

Если кому-либо такая подача материала покажется слищком

примитивной, то мы заметим, что дискуссия двух авторов списана

с реальных занятий по программированию, а в каждом из трех

высказываний содержатся зерна истины, развитие которых

постепенно приведет нас к решению задачи. В частности, мы

немедленно попробуем обобщить сделанные замечания авторов программ

в виде некоторых отправных принципов.

А. При сочинении программы мы из соображений удобства и

логичности вводим различные обозначения для исходных и

промежуточных величин задачи и для ее результатов. Если после

получения символической программы распределить память по

принципу «каждой величине свою ячейку», то может оказаться,

что памяти будет израсходовано больше, чем это «на самом деле»

нужно. Этот факт можно выразить и по-другому: можно переписать

программу так, что она будет решать ту же задачу, но содержать

меньшее количество обозначений.

Б. Сокращать число велр1чин программы можно следующим

образом: имея в команде (или операторе) некоторый результат,

не надо торопиться вводить для него новое обозначение, а

посмотреть, нет ли в данный момент «свободной» величины, т. е. такой,

текущее значение которой больше не потребуется. Если такая

величина есть, то она и берется в качестве обозначения результата.

Новые примеры. Рассмотрим еще некоторое количество

примеров. Пусть надо вычислить у = я59, опять-таки, не используя

§ i 2. НАКОПЛЕНИЕ ФАКТОВ. ЛИНЕЙНЫЕ ПРОГРАММЫ tf

операцию возведения в степень. Конечно, имея перед глазами

пример 3, уже никому не захочется писать подряд 58 команд

умножения, так что первый подход даст нам

Пример 4. Вычислить я59.

начало вещ х, у, цел ί;

ввод (х);

у: = хХх;

для ί: = 1 шаг 1 до 57 цикл у := уХх;

вывод (у)

конец

Однако эта программа, будучи весьма короткой, тем не менее

очень долго работает: на решение задачи расходуется по меньшей

мере 3x57 действий: умножение, изменение i и сравнение его с 57.

В то же время, если бы надо было вычислить 264 (64 = 26), то на

это потребовалось бы всего 6 умножений:

У

У

У

У ■

У-

У ■

:= хХх

:= УХУ

:= УХУ

= уху

= уху

= уху

(χ2),

(X4),

(*"),

(*16),

(х32),

(*«)·

Однако это нарастание степеней * двойки в геометрической

прогрессии поможет нам и в нашем случае. (А заинтересованный

читатель без труда теперь додумается до правила для любого целого

показателя степени.) Представим 59 как сумму степеней двойки:

59 = 32 -f-16 -f- 8 + 2 + 1 .{Тогда программу организуем так:

вычислим подряд и сохраним значения степеней χ с показателями,

равными степеням двойки, так чтобы последняя степень двойки была

бы еще меньше исходного показателя, а следующая — уже

больше. А потом перемножим друг на друга те степени х, у которых

значения показателей входят как слагаемые в представление

исходного показателя:

ХЪ9 = χΜχχΜχχ*Χχ*χΧβ

В результате получаем

Пример 5. Вычислить хъо.

начало вещ #, у, х2, χί, χ8, х16, #32;

ввод (х);

Х£ . — X /\ Д/,

х4 := х2Хх2\

х8 := хАхх4;

χίβ := я8хя8;

*32 := ИбхИб;

18 ГЛ. 1. СОДЕРЖАТЕЛЬНЫЙ АНАЛИЗ ЗАДАЧИ

у :== хХх2;

у := уХх8;

у := yXxlft;

у := уХ#32;

вывод (г/)

конец

В заключительной части программы мы, иод влиянием опыта

1-го и 2-го примеров, уже «вели вычисление через ι/», экономя

обозначения промежуточных величин. Однако принцип Б

побуждает нас более внимательно проверить программу и спросить себя,

везде ли мы вводили новые величины «по необходимости», а не

по инерции начальной идеи вычисления #59? Наше рассуждение

звучит примерно следующим образом. Занумеруем операторы

программы:

1: х2: = хХх;

2: #4: = #2 χ #2;

3: х8: = хАххА;

4: #16: = #8х#8;

5: #32: = #16х#16;

6: у:= хХх2;

7: у: = ухх8;

8: у:= yXxlft;

9: у:=ух32.

Результат оператора 1 мы не можем присвоить #, так как тогда

новый χ будет равен #2, а нам нужен исходный χ в операторе 6.

Результат оператора 2 мы не можем присвоить ни #, ни х2 по той же

причине. Однако после выполнения команды 3 нам уже не нужна

величина #4 и мы можем ее результат присвоить той же

переменной, заменив, естественно, х8 в командах 4 и 7 на #4. Просмотрев

программу до конца, мы видим, что это единственная экономия

на величинах, которую мы можем здесь себе позволить.

Пример 6. Вычислить #59.

начало вещ #, у, #2, #4, #16, #32;

ввод (х);

ΧΔ . —= X /\ Ху

#4:= #2х#2;

#4: = хАХхА;

#16:= #4 χ #4;

#32:= #16х#16;

у:= хХх2;

у:= yxxi;

§ 1.2. НАКОПЛЕНИЕ ФАКТОВ. ЛИНЕЙНЫЕ ПРОГРАММЫ 1£

у: = г/χ #16;

у: = уХх32;

вывод (у)

конец

Наши кропотливые рассуждения о невозможности сэкономить

обозначение величины во всех пяти первых операторах, кромо

3-го, позволяют нам, однако, догадаться о причине этой

невозможности: мы плохо организовали нашу программу Мы сначала

посчитали все «степени двойки», а только после этого начинаем

их использовать. Поступим по-другому: получив очередную

«степень двойки», мы ее тут же «вгоним» в у, если она является

слагаемым нашего показателя. Если же нет, то мы только

употребим ее на получение следующей «степени двойки».

Одновременно стараемся соблюдать принцип Б. Получаем

Пример 7. Вычислить хЪ9.

начало вещ х, у, х2\

ввод (х);

χδ :== χ χ Ху

у: = хХх2;

х: = .г2х.г2;

Х\== Χ X Х\

у\= уХх\

х:= хХх

у:= ухх;

X. — X X X)

у:= уХх;

вывод (у)

конец

Этот результат удовлетворит всякого, но вы, читатель, не

будете настоящим исследователем, если не спросите себя, а нельзя

ли обойтись меньшим количеством величин? Утвердительный:

ответ, по-видимому, будет небольшим открытием для большинства;

Π ρ и λΐ е ρ 8. Вычислить я59.

начало вещ х, у;

ввод (χ);

У

X

У

У

X

У

X.

— X X Ху

= хху;

= уху;

■= уху;

= хху;

= уху;

= хху;

20

ГЛ. 1. СОДЕРЖАТЕЛЬНЫЙ АНАЛИЗ ЗАДАЧИ

#:= уху;

у: = хХу;

вывод (у)

конец

Тем, кто не додумался до этого примера, автор рекомендует в

качестве «утешительного забега» доказать, почему в этой

программе нельзя обойтись меньшим количеством величин, т. е.

одной.

Пауза для размышления. После этих восьми примеров мы

накопили достаточно материала, чтобы в нем разобраться, прежде

чем двинуться дальше. Во-первых, мы окончательно поняли, что

число обозначений величин в программе и число ячеек памяти —

это непосредственно связанные друг с другом характеристики

программы. Нет никакой принципиальной разницы между

переменной величиной программы в алгоритмическом языке и ячейкой

памяти машинной программы. Пока мы заняты построением

программы, мы можем эти понятия отождествлять, й" это нам

действительно удобнее для рассуждения. Величина в программе — это

не столько какая-нибудь физическая или математическая

переменная величина, проникшая в программу из исходной

формулировки задачи, сколько в чистом виде элемент памяти,

своеобразная камера хранения. В такой камере хранения хранится

некоторое значение. Поступить туда оно может только как результат

некоторого оператора или команды. Старое значение

переменной величины при этом перестает существовать. Каждое значение

в разумно составленной программе вырабатывается для того, чтобы

позднее быть использованным в качестве аргумента в каком-то

месте программы. Пока оно еще не использовано, хранящая его

переменная величина «неприкосновенна» и ей нельзя присваивать

нового значения. Таким образом, сколько величин используются

в разных вариантах программы и как они обозначаются — не

столь существенно, как то, что они должны сохранять все

информационные связи в программе, т. е. «передачи» значений от

результатов одних операторов к аргументам других.

Второй вывод состоит в том,-что существуют различные способы

построения вариантов программы, как-то влияющих на количество

величии в программе и их обозначения. Первый способ состоит

в том, что мы имеем, по существу, одну и ту же программу с

различными наборами величин. Программа одна и та же в том смысле,

что она состоит из одних и тех же команд с одними и теми же

зависимостями аргументов одних операторов от результатов других

(примеры 1 и 2, 5 и 6, 7 и 8). Выигрываем мы на том, что согласно

принципу Б мы не заводим без нужды новые величины, а

стараемся обходиться уже имеющимися. Второй способ сохраняет состав

команд и зависимости между результатахми и аргументами, но

§ 1.2. НАКОПЛЕНИЕ ФАКТОВ. ЛИНЕЙНЫЕ ПРОГРАММЫ 21

разрешает перестраивать команды в программе, если это помогает

делу (примеры 6 и 7). В природе экономии памяти в этом способе

мы, скорее всего, еще не разобрались, не считая несколько

расплывчатого утверждения, что если организовывать вычисления

так, чтобы использовать результат по возможности сразу после

получения, то можно сократить потребность в памяти для

хранения значений. Наконец, третий способ дает эффект благодаря

полной перестройке программы, при этом, в общем случае,

экономится память не для величин (в примере 3 мы даже ввели еще

одну величину Ϊ), а для программы, которая благодаря циклу

становится более короткой. Первый способ, однако, в каком-то

смысле является самым основным: каким бы способом мы ни

получили программу, если мы хотим получить максимальную

экономию памяти, мы должны проверить, не содержит ли она

лишних величин, и постараться найти наилучший вариант (как в

случае примера 8).

Наконец, мы должны отдавать себе отчет, что мы еще очень

далеки от решения общей задачи экономии памяти* У нас в запасе

«есть только один принцип Б в качестве рабочего правила, а все

наши примеры исчерпываются простейшим видом программ, так

называемыми линейными программами, т. е. программами, не

содержащими ни условных операторов, ни циклов, ни ссылок на

процедуры вычисления функций (примеры 3 и 4 не в счет, так как

мы их не анализировали). При этом даже для линейных программ

принцип Б еще не носит характера формального правила и

требует дальнейшей проработки, чем мы и займемся.

Информационные связи и сечения. Поразмышляем еще раз над

принципом Б в попытках превратить его в систематическую

процедуру: «не надо торопиться вводить для результата новое

обозначение, а посмотреть, нет ли в данный момент освобождающейся

величины, т. е. такой, текущее значение которой больше не

потребуется». Эти слова подсказывают нам, что мы, решая задачу

экономии памяти, должны просмотреть операторы программы в

порядке их выполнения. Тогда (в случае линейной программы,

записанной в столбик) выше очередного просматриваемого нами

оператора будут операторы уже выполнившиеся, для которых

мы уже как-то распорядились выбором величин, и ниже будут

команды, еще не выполнившиеся. Мы не торопимся ввести новую

ьеличину для результата очередного оператора 5, а смотрим на

величины, обозначающие результаты операторов, стоящих выше.

Что значит, что величина ν, которая была результатом оператора R,

еще не освободилась? Это значит, что ниже оператора S есть еще

один оператор, Г, имеющий ν своим аргументом. Достаточно ли

точное это определение? Легко можно догадаться, что нет. Путем

комбинирования возможных случаев получим такие варианты

выработки и использования величины ν по отношению к оператору S

22

ГЛ. 1. СОДЕРЖАТЕЛЬНЫЙ АНАЛИЗ ЗАДАЧР1

(для четкости будем полагать, что никаких других

использований величины ν, кроме явно показанных, в программе нет):

Программа Программа Программа Программа

R: ν :=...

S: χ :-—...

Τ: ζ := F(v)

R: ν :=...

Τ': ζ := F'{v)

S: χ :—...

Τ: ζ := F(o)

Β: ν :=...

Τ': ζ := *"(ι?)

Λ" : χ :—...

Τ: ζ := /»

7?: ν :=...

Τ": 2 := F»

iS*: ж :=

случай а)

случай б)

Случай в)

случай г)

Посмотрев на эти картинки, мы заключаем, что единственным

условием того, что величина ν занята по отношению к оператору Sr

является такая ситуация, что S находится между (в смысле

положения в программе) выработкой ν (оператор R) и использованием

ν (оператор Г);,при этом между S и Τ нет оператора,

вырабатывающего v. Получается, что оператор S стоит как бы на пути

передачи значения от R к Т. Эту ситуацию можно сделать более

наглядной, если изобразить этот путь величины ν в виде линии,

соединяющей результат оператора R и аргумент оператора Τι

Я:

Г:

-Ж»))

Если допустить, что в нашей программе таким образом

обозначены все пути передачи значений от результатов к аргументам,

то принцип Б*сильно упрощается: для оператора S занятыми

являются все величины, пути которых «пересекают» этот оператор»

Не поленимся нарисовать эту картинку (рис. 1.1) для какого-

нибудь из наших примеров, хотя бы пятого (сразу соображаем,

что χ для оператора ввода является результатом, а у для

оператора вывода — аргументом).

Программа выглядит более громоздкой, но в то же время для

наших целей необычайно ясной. Мы проложили по ней все пути

передачи значений величин — от результатов к аргументам.

Давайте сразу их назовем информационными связями между

аргументами и результатами операторов. Все эти связи

ориентированы «вдоль» по направлению выполнения программы. Аналиа

этих связей дает нам полное представление о том, как надо

распределять память в программе. Действительно, подчеркнем

мысленно каждый оператор горизонтальной линией, которая будет

отмечать момент выполнения этого оператора. Назовем эту линию

сечением программы. Тогда число информационных связей, пере-

§ 1.2. НАКОПЛЕНИЕ ФАКТОВ. ЛИНЕЙНЫЕ ПРОГРАММЫ

23

секаемых сечением, показывает нам, сколько величин в

настоящий момент «занято», т. е. используются для хранения

результатов, которые выработаны раньше, но потребуются позднее, а

символы величин, сопоставленных концевым точкам этих «маршрутов»,

указывают, какие конкретно величины используются.

качало вещественные

двод

x,y,xZ,x4, х8,х16у xoZl

■@

<ε>

<д

<д

<д

= 0X0

= <£>

= ©

конец

быбод [(у

X

X

X

я) X

©

©

И) X {xt

ъ

а) х \$а

у) X \х16)

у) X Ш

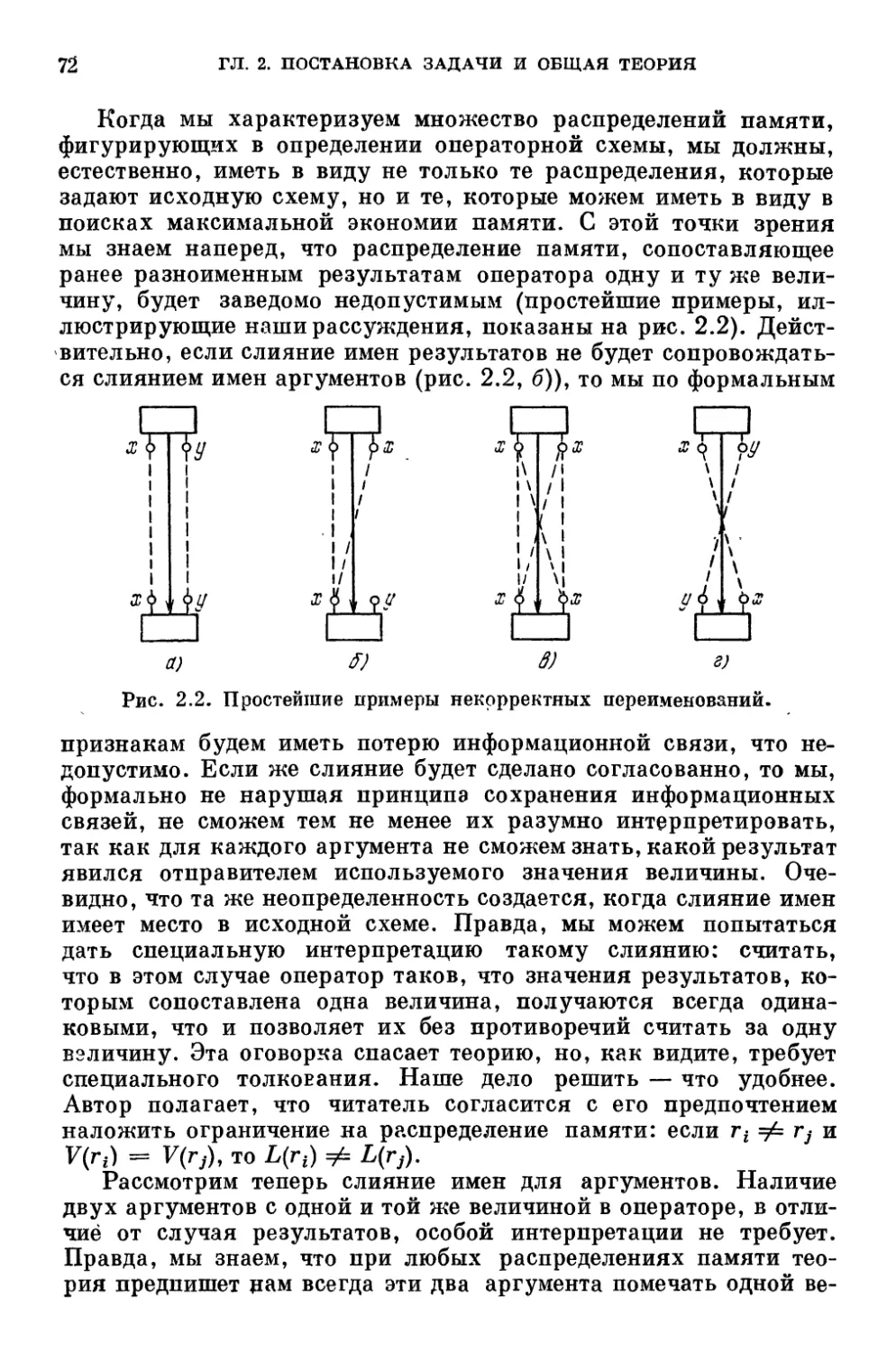

Рис. 1.1. Программа с проложенными информационными связями.

Последнее наблюдение немедленно подсказывает нам

систематическую процедуру переобозначения величин программы,

дающую наименьшее количество обозначений· Чтобы подчеркнуть ее

24

ГЛ. 1. СОДЕРЖАТЕЛЬНЫЙ АНАЛИЗ ЗАДАЧИ.

систематичность, мы намеренно выберем совсем другие

обозначения: Й, t2 и т. д.

Процедура экономии памяти в линейных программах?

1. Начальный шаг: берем первый оператор. Он

содержит только результат, которому сопоставляется величина ti.

Имя этой же величины сопоставляется всем аргументам

операторов, к которым ведут от этого результата информационные связи.

2. Очередной шаг: берем очередной оператор 5 ν Пусть

к этому времени уже использованы некоторые величины. Из этого

набора, отбрасываем занятые величины, т. е. величины,

информационные связи которых пересекаются сечением оператора S. Если

в наборе останутся величины, выбираем из них любую (например,

с наименьшим номером) и сопоставляем ее результату оператора S*

Если все использованные величины «заняты», добавляем к ним

еще одну, которую и сопоставляем результату. Имя величины,

сопоставленной результату оператора S, сопоставляем всем

аргументам операторов, к которым ведут от этого результата

информационные связи.

Очевидно, что если для каждого аргумента есть задающий его

результат, то все величины программы получат новые имена;

при этом их будет всего ровно столько, какова максимальная

ширина сечений программы, т. е. максимальное количество

промежуточных значений величин, которые нужно хранить в

какой-либо момент выполнения программы. Действительно, согласно

процедуре мы добавляем к списку использованных величин новую

только тогда, когда все величины заняты, а нам надо увеличить

текущую ширину на единицу добавлением новой

информационной связи.

Применив эту процедуру к рис. 1.1, мы получим следующую*

программу:

начало вещ ti, t2, t3

ввод (ti);

t2:

t3:

t3

Й:

*5:

ti:

ti:

ti

ti

= tixtl;

= t2xt2;

:= t3xt3;

= ί3χβ;

= tAxtA;

= tlx t2;

= ti X t'S;

= tlXtA;

= *lx*5:

вывод (ti)

конец

Только что полученная процедура является серьезным шагом:

вперед. Мало того, у нас уже зреет убежденность, что она пол-

§ 1.2. НАКОПЛЕНИЕ ФАКТОВ. ЛИНЕЙНЫЕ ПРОГРАММЫ

25

тюстью решает вопрос об экономии памяти в линейных

программах. Это побуждает нас продолжить ее анализ.

Операторная схема. Возможно, кое-кто из читателей уже

обратил внимание на то, что после того как мы построили

информационные связи программы, исходные имена величин,

употребленных в ней, нам уже не нужны. Мало того, они нам даже мешают,

£>):

О

О

О

О

Ό

О

О

О

О

-О

^6

^~6

•6

=Ъ

=ъ

=ъ

^ъ

ъ

X

X

X

X

X

X

ъ

ъ

δ

Ъ

= ό*ό

ъ

ъ

Рис. 1.2. Информационные связи делают имена величин ненужными.

«загораживая» те места, в которых мы должны согласно процедуре

проставлять имена новых величин. Нам будет приятнее работать

с программой без величин — только с кружками, отмечающими

места аргументов и результатов операторов (рис. 1.2).

26 ГЛ. 1. СОДЕРЖАТЕЛЬНЫЙ АНАЛИЗ ЗАДАЧИ

При взгляде на это графическое изображение программы нам:

начинает бросаться в глаза неуместность алголовской

стилистики и прочей информации о программе, которая была неотъемлемой

частью при составлении программы, но становится не столь

существенной при решении нашей специальной задачи об экономии

памяти. Мы уже распрощались со списком описаний величин, да

и с самими величинами после того, как они сослужили свою

службу в построении информационных связей. Что же нам нужно по

существу? Нам нужно знать, что операторы образуют линейный

порядок. Для каждого оператора нам нужно знать, сколько у

него аргументов и результатов (оператор ввода, например, может

иметь несколько результатов). Нам совсем не важно, какую

функцию выполняет оператор. Другими словами, нам достаточно знать

не саму программу, а только ее схему, в которой были бы только

обозначения операторов, а не их содержание, был бы указан

порядок их выполнения, были бы как-то отмечены их аргументы и

результаты, притом так, чтобы было удобно изображать их

информационные связи и подписывать к ним имена величин. При всем:

при этом мы уже оценили полезность графического представления

такой, как ее естественно назвать, операторной схемы.

Оставляя чргтателя в неведении относительно множества

картинок, перерисованных разными авторами в поисках наглядности,

мы сразу предложим ему операторную схему нашей программы

в уже общепринятом графическом оформлении (рис. 1.3).

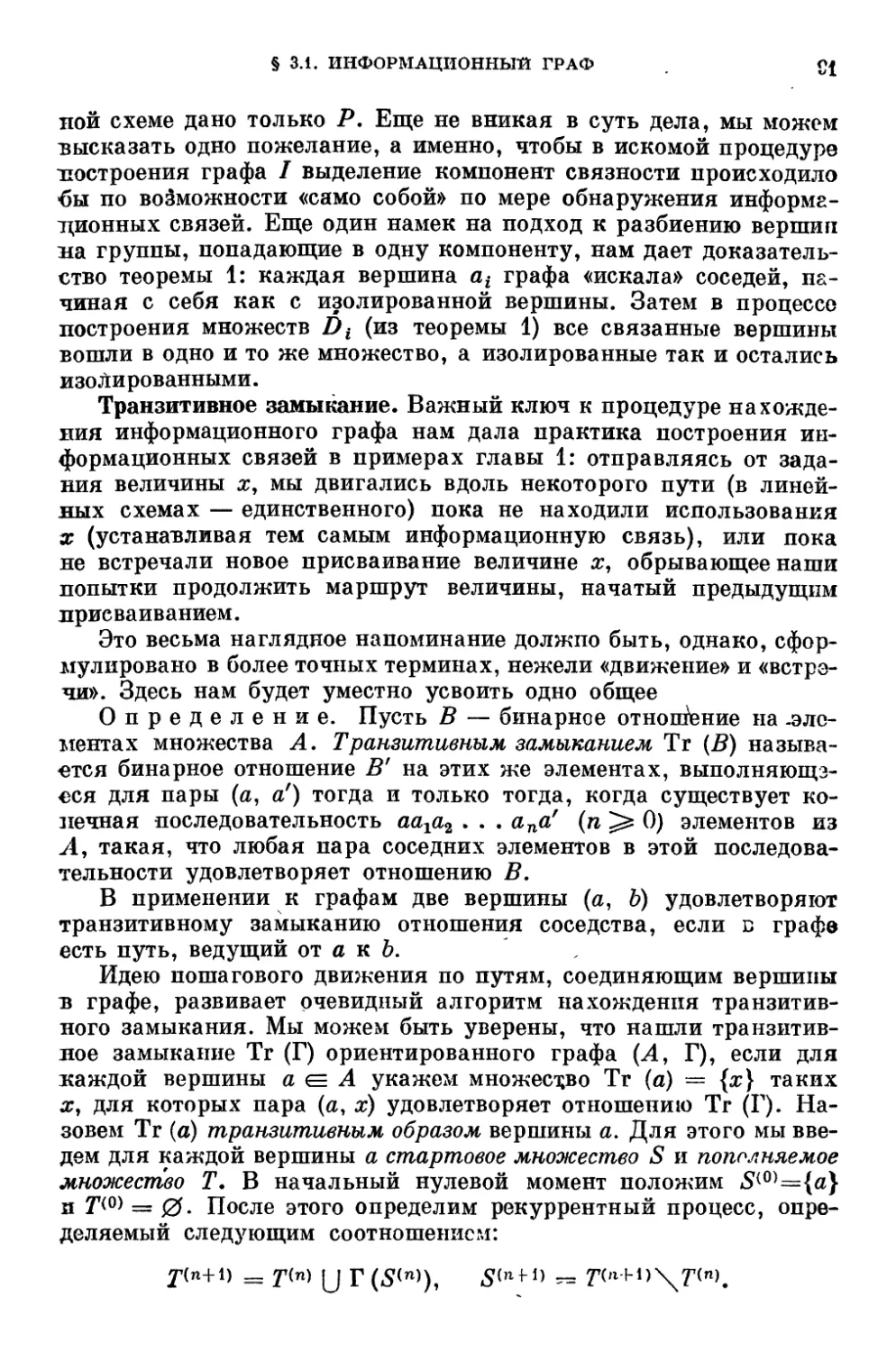

Прямоугольниками изображены операторы. Их обозначения:

ставятся внутри. Жирные стрелки указывают на порядок

выполнения операторов. Маленькие кружки на отросточках —

аргументы и результаты. Отростки, идущие по ходу стрелок,—

результат, а напротив — аргументы. Имена величин, сопоставленные

аргументам и результатам, пишутся рядом с кружочками (рис. 1.3Г

а). Пунктирные стрелки — информационные связи. Чтобы не

загромождать чертежи (рис. 1.3, б), там, где это удобно,

пунктирные стрелки, идущие от одного результата, сливаются в одну

связку. Такое графическое сокращение даже удобно по существу:

если подсчитывать ширину сечения, нужно все стрелки, идущие

от одного результата, считать за одну, т. е. как раз считать

связками. На этом чертеже информационные связи нарисованы с

«вывертами» — не по кратчайшему расстоянию,— для того,

чтобы более четко показать ширину информационных связей.

Графическое представление схемы программы и ее

информационных связей делает гораздо более понятным эффект

перестановки операторов программы в примере 7 (рис. 1.3, в): сократив,

маршруты передачи значений от результатов к аргументам, мы

разгрузили информационные связи и сократили их ширину до·

двух, что, кстати, в отличие от программы примера 7, видно на

©той схеме с очевидностью.

§ 1.2. НАКОПЛЕНИЕ ФАКТОВ. ЛИНЕЙНЫЕ ПРОГРАММЫ

27

1 А |

χ б f

p<2

1 в |

х'1б [

p x2

Li '

<ζ·4 <* 1

о xb

[J^J

< px8

f^j

2,16 о '

f 0_X16

Г- I

I А I

χ Q { 9zl I

га !

J/ S ^

\ о x8

L/ I !

A

Ρ Ч

\oXf6 \

ι/_j ι

ox32

I 7 I

I A |

г-*

Ь

II в I

b

im

'ТУШ

!!l·^ I

TfTi

ь

! Η

b

! 11 ira

1 1 ^SJ

r*

! I 1 £ 1

L >

1 X*<\ ]

;?

! 1 # 1

1 r^T

1 l·

:?

I / 1

4 J

■*?

m

Г r

I иг |

j_/r ]

a)

S)

δ)

Рис. 1.3. Операторные схемы,

а) Пример 5. б) Информационные связи примеров 5 и 6. в) Информационные

связи примеров 7 и 8.

28

ГЛ. 1. СОДЕРЖАТЕЛЬНЫЙ АНАЛИЗ ЗАДАЧИ

Связки. Ширина сечений. Похоже, что мы уже исчерпали все?

полезные факты, которые нам могут дать линейные программы.

Главными нашими достижениями являются открытие важности

анализа информационных связей программы, а также извлечение

из программы тех и только тех ее характеристик, которые нам^

помогают в решении задачи экономии памяти и которые

изображаются в виде ее операторной схемы. После того как мы уже

несколько освоились с этой находкой, давайте разберем подробнее,

что такое информационная связь, как мы ее находим по заданной

программе и как используем для распределения памяти. Мы

прокладываем связь от результата оператора S к аргументу

оператора Г, если S имеет своим результатом некоторую величину хл

Τ имеет χ своим аргументом, Τ выполняется позже S, т. е. от S

к Τ ведет цепочка операторов, и, наконец, в этой цепочке ни один

из операторов не имеет χ своим результатом. Для построения

информационных связей и вообще, для решения задачи экономии:

памяти, нам достаточно иметь операторную схему программы,

в которой указаны символы операторов, их аргументы,

результаты и сопоставленные им имена величин, а также порядок

выполнения операторов.

После построения всех информационных связей программы

исходное распределение памяти нам уже не нужно. Мало тогог

по совокупности информационных связей мы можем построить

любое другое распределение памяти в данной программе, в том

числе и самое экошшное по числу использованных величин.

Информационные связи в операторной схеме группируются в

связки. В одну связку входят все информационные связи,

выходящие из некоторого результата. Для правильного распределения

памяти нужно, чтобы всем аргументам и результату, входящим:

в связку, была бы сопоставлена одна и та же величина. Самое

неэкономное распределение памяти получается, когда каждому

результату, или, что то же самое, каждой связке сопоставляется

своя величина. Экономия памяти достигается тогда, когда

нескольким связкам сопоставляется одна и та же величина. Однако чтобы

не нарушить информационные связи, нельзя сопоставлять одну

и ту же величину конкурирующим информационным связям.

В линейной программе конкурирующими являются те и только те

связки, которые одновременно пересекаются каким-либо сечением

ее операторной схемы. Для линейной программы есть простой

алгоритм нахождения экономного распределения памяти. Число-

используемых величин при этом оказывается равным ширине^

сечений, т. е. максимальному числу связок, рассекаемых сечениями.

Эти выводы мы теперь примем в качестве рабочих гипотез,

которые будем проверять на более разнообразных примерах в

поисках новых фактов. Очевидно, что прежде всего нам надо

усложнить структуру программ.

§ 1.3. НАКОПЛЕНИЕ ФАКТОВ ПРОГРАММЫ ОБЩЕГО ВИДА 29

§ 1.3. Накопление фактов. Программы общего вида

Программа с условиями.

Пример 9. Решить квадратное уравнение ах2 + Ьх + с = О

для общего случая. Комплексное решение представить в виде

значений модуля и аргумента комплексно сопряженных корней.

Представив общую формулу решения

— Ь ± УЪ2 — 4ас

#1,2 =

2а

Ь У\ б2 — Аас |

в виде ρ = —γ- и q = π » мы затем в зависимости or

знака дискриминанта Ъ2 — 4ас найдем для действительного

случая призн = 1, κορί = ρ + q и ио/?2 = ρ — #, а для комплекс-

q

ного — призн = —1, κορί = ]/р2 + д2 и кор2 =arcsiny g _^_ a .

В результате введя для экономии вычислений еще несколько

промежуточных величин, но в то же время не стремясь

расписать все формулы до последней операции, получим программу:

начало вещ а, Ъ, с, ti, Й, дискр, р, q, κορί, κορ2:

цел призн;

ввод (а, 6, с);

ί1:= 2χα;

*2:= 2хс;

дискр:= b\2 — tlxt2;

р:= —b/ti;

q:= sqrt(abs(ducKp))/tl;

если диск/? < 0 то

начало

il:=pf2 + ?t2;

κορί: = sqrt(ti);

кор2: = arcsin (q/κορί)

конец иначе

начало

κορί:= ρ + q;

κορ2:= ρ — q;

конец;

призн:= sign (дискр);

вывод (призн, κορί, κορ2)

конец

Маршрут. Построим теперь йля этой программы ее

операторную схему. Она уже не будет линейной, потому что в ней

содержатся взаимноисключающие участки вычислений (случай

отрицательного и неотрицательного дискриминанта). Для удобства

so

ГЛ. 1. СОДЕРЖАТЕЛЬНЫЙ АНАЛИЗ ЗАДАЧИ

,_ri?

ал£

ι _

I г*

τ1

\

I

! i

1 ' ЧГ

■-I-I—-δ"

ι ι

Зис

г"} Ι ^

I »gjf

-1

-raL

ί/'

--ό

-2-

/Ш/

~-0

LL

l·^-

^Λ

Π

-=δ"

Lc;

Й

Τ

Г? Л—

ι ι

ι ι

I I

-М-

I!

ι ι

ι ι

Ι μ^

I ·

/W/

rf

( J_

ι ι

■?H

Рис. 1.4. Операторная схема, содержащая условие.

' § 1.3. НАКОПЛЕНИЕ ΦΛΚΤΟΕ. ПРОГРАММЫ ОБЩЕГО ВИДА 31

дальнейшего анализа обозначим каждый из операторов именэм.

величины, сопоставленной его результату, сделав очевидные

исключения для операторов условия и вывода. На схеме (рис. 1.4)

проложим информационные связи, используя то же правило: связь

прокладывается от результата оператора S к аргументу

оператора Ту если им сопоставлена одна и та же величина χ и существует

хотя бы один путь по схеме от S к Г, вдоль которого ни один из.

операторов, кроме S, не вырабатывает величину х. У нас уже

промелькнуло образное сравнение этого пути с маршрутом

доставки значения величины χ от оператора S к оператору Г.

Сейчас нам, пожалуй, будет самое подходящее время закрепить этот

образ в виде термина. Одно из новых явлений, которые мы

обнаружили на этой схеме, это то, что доставка значения от результата

к аргументу, т. е. реализация проложенной информационной

связи, может происходить более чем по одпому маршруту: значение·

дис доставляется к оператору призн либо по маршруту (due, p, qy

<C,2l', κορί,κορ2, призн),либо(дис,р,д,<С, κορϊ',κορ2!, призн).

Второе наблюдение касается связок информационных связей:

до сих пор каждая связка была как бы пучком стрелок, идущих

от одного результата к нескольким использующим его

аргументам. Сейчас же (рис. 1.5) их конфигурация усложнилась: в случае

γ

I \

I \

ι

\ г1 1 /

Υ γ

/

/

/

'

\ /

•

, , γ

*)юр1 δ)κορΖ

Рис. 1.5. Новые виды связок для κορί и кор2.

связки кор2 информационные связи группируются у аргумента„

а в связке κορί группировка произошла и у аргумента, и у

результата. Это заставляет нас сделать заметку на будущее (правда „

очень скорое): при выборе имени величины для обозначения

результата это имя нужно расставить не только на аргумент (или

аргументах), двигаясь по стрелкам, но и потом перенести имл

« этого аргумента на другой результат, навстречу стрелке

соответствующей информационной связи.

32

ГЛ. 1. СОДЕРЖАТЕЛЬНЫЙ АНАЛИЗ ЗАДАЧИ

Следующее, что мы хотим сделать,— это провести сечения

последовательности выполненных операторов, чтобы определить

конкурирующие информационные связи и число величин в

экономном распределении памяти. При проведении сечений мы опять-

таки сталкиваемся с новыми фактами. У нас по-прежнему есть,

как бы сказать, доминирующее направление вычислений,

задаваемое стрелками между операторами, при этом распадающееся

на некотором участке на две ветви, которые потом снова сходятся.

Мы уже понимаем, что на нашем примере изображен простейший

случай и что, желая выжать из этого конкретного примера все

лолезное, мы должны стараться сформулировать наши

возможные новые правила в наиболее общей форме. Само понятие

сечения не зависит от сложности схемы. Мы всегда рассекаем только

одну стрелку перехода от одного оператора к другому. Вопрос

в том, какие информационные связи мы рассекаем этим сечением.

Раньше ответ был прост: все те, которые начинаются выше и

кончаются ниже данного сечения. Простота его для линейной

программы была в том, что каждый оператор программы оказывался

либо ниже, либо выше сечения. Здесь это уже не так: выше или

ниже оператор κορί по отношению к оператору кор2 — этот

вопрос не имеет ни смысла, ни ответа. Вспомним, однако, как мы

использовали сечение: мы каждой пересекаемой информационной

связке сопоставляли величину, хранившую выработанное

значение и говорили себе: вот эти величины заняты в момент

выполнения рассекаемого оператора *), поэтому его результат нельзя

присвоить ни одной из этих занятых величин, и информационная

связь, начинаемая этим результатом, является конкурентной со

всеми другими рассекаемыми информационными связями. Тогда

мы можем сказать так: сечение некоторого оператора S рассекает

по определению те и только те информационные связи, маршруты

которых содержат 5, или: информационная связь, начинаемая

результатом некоторого оператора 5, конкурентна с теми и

только с теми информационными связями, маршруты которых

содержат S·

Эта формулировка, хотя и выглядит более сложной, зато

более непосредственно выражает суть дела (принцип сохранения

информационных связей), а главное,— уже не зависит от

конкретной сложности схемы: если мы знаем информационные связи и

реализующие их маршруты, мы можем построить все сечения,

ибо вопрос о принадлежности того или иного оператора тому или

иному маршруту решается однозначно.

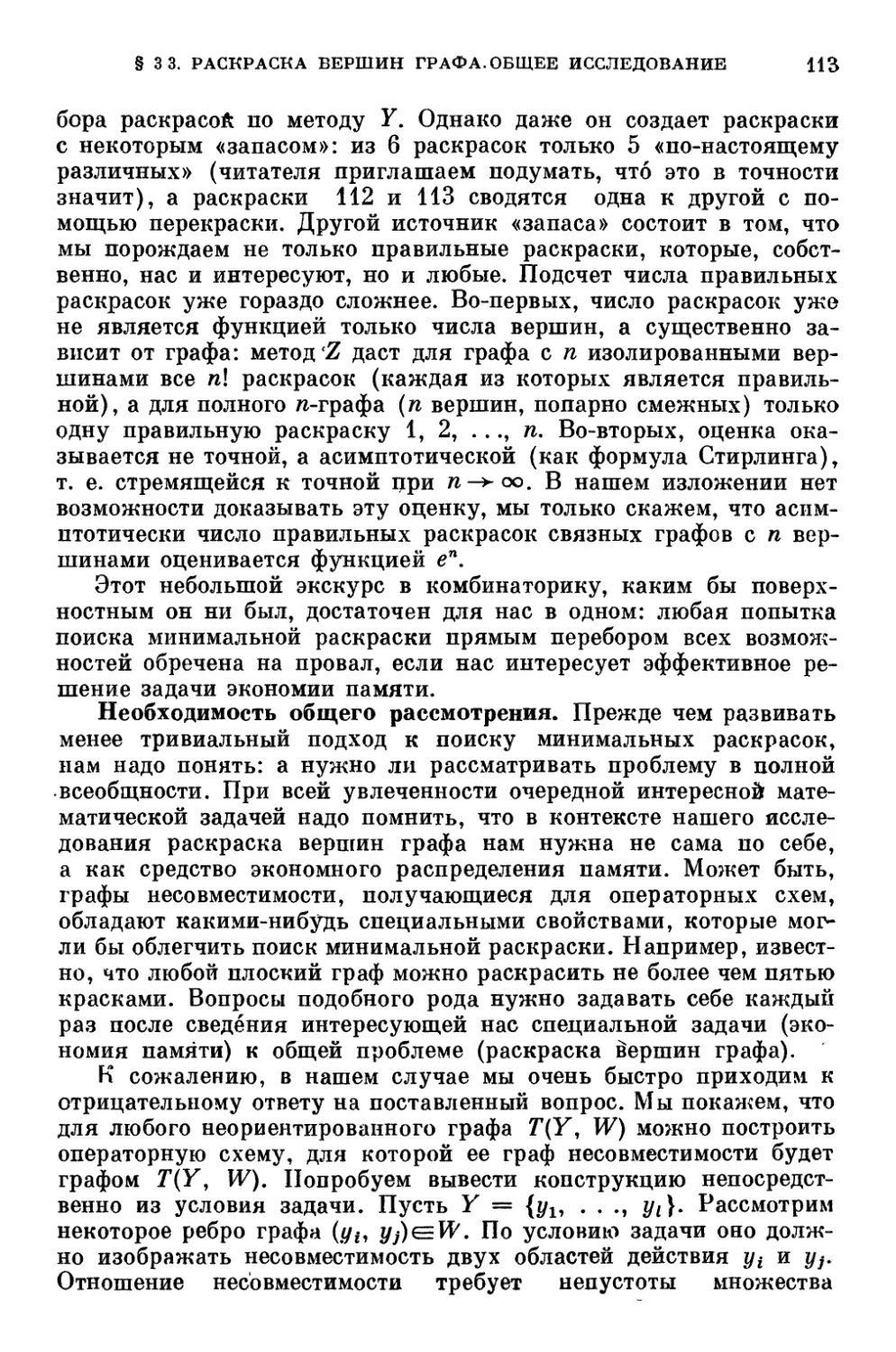

Подробная процедура экономии. На рис. 1.6 изображены все

14 сечений схемы примера 9. Нам с ними еще придется поработать,

*) Мы для краткости употребляем вольное выражение, так как рассекаем

фактически не оператор, а выходящую из него стрелку перехода.

§1.3. НАКОПЛЕНИЕ ФАКТОВ. ПРОГРАММЫ ОБЩЕГО ВИДА

©-

©-

®-

©-

®-

&

<2>

®-

0-

ОУ-F

I

гг-

^4—

^

if

-зл

L^J

кор1

L-t—

7&

I

jz±z

кор2

н5ПГ

-rr-i J

44-

-^

I I

tz

Ί ' _

^ffi

due

ν—

·**

!*

■—гз£

—" ;i«

en:

LJl k-

/?Ш/У

игзг

г-ι

Sr

j a

wpf

I-37

®

r-4

xopf

I

-&

-@4

-®3

Рис. 1.6. Распределение памяти для примера 9.

34 ГЛ.*1 СОДЕРЖАТЕЛЬНЫЙ АНАЛИЗ ЗАДАЧИ

поэтому они занумерованы. Справа указана ширина каждого

сечения, т. е. количество взаимно конкурирующих информационных

связей. Максимальная ширина равна четырем.

Приступим к распределению памяти согласно процедуре,

отработанной нами'для линейных программ. Нам имеет смысл одивг

раз выполнить ее-во всех деталях. Читателю рекомендуется

перерисовать рис. 1.6 без имен величин и проставлять их на рисунке*

по мере продвижения по схеме.

Сечение 1. Три результата. Обозначаем их а, & и с и

переносим имена на' аргументы по направлению информационных,

связей.

Сечение 2. Новый результат, Ъ и с заняты, а свободно-

Обозначаем им результат и соответствующие аргументы.

Сечение 3. Новый результат, а и Ъ заняты, с свободно·.

Обозначаем им результат и (соответствующие) аргументы.

Сечение 4. Новый результат, а и Ъ заняты, с свободно-

Обозначаем им результат и аргументы.

Сечение 5. Новый результат, α и с заняты, Ъ свободно-

Занимаем его.

Сечение 6. Новый результат, Ъ и с заняты, а свободно-

Занимаем его.

Сечение 7. Результатов нет.

Сечение 8. Новый результат, а и с заняты, Ъ свободно-

Занимаем его.

Сечение 9. Новый результат, а к с заняты, Ъ свободно-

Занимаем его. Однако, когда мы перенесем Ъ на аргументы

операторов кор2 и выв, мы увидим, что эта же величина должна быть

соотнесена результату оператора κορί'. Однако этого делать

нельзя, так как в сечении 12 этот результат конкурирует, в частности,

с информационной связью от ρ к кор2\ которой в свое время уже-

была сопоставлена величина Ъ. Нам не остается ничего другого,

как взять для рассматриваемой связки κορί новую величину d-

Сечение 10. Новый результат, с и d заняты, а и Ъ свободны.

Берем а в качестве величины для результата и опять

обнаруживаем, что его надо перенести и на результат кор2'. Анализ 13-п>

сечения, однако, позволяет это сделать.

Сечение 11. Результатов нет.

Сечения 12и13. Величины результатам уже сопоставлены-

Сечение 14. Новый результат, а и d заняты, Ъ и с свободны-

Занимаем Ъ.

Проанализируем итог работы. В первом приближении

процедура экономии памяти сработала как нужно: максимальная ширина

схемы (12-е сечение) равна четырем, именно столько величин мы

использовали. Анализ сечений по-прежнему давал нам сведения:

о занятых величинах в момент выполнения рассматриваемого

оператора. Однако ситуация, с которой мы столкнулись в 9-м сечении,.

• § 1.3. НАКОПЛЕНИЕ ФАКТОВ. ПРОГРАММЫ ОБЩЕГО ВИДА £5

нам показала, что для того, чтобы принять здесь правильное

решение о конкурирующих связках, нам оказалось необходимым,

двигаясь вдоль (и навстречу) стрелок информационных связей,

образующих связку, просмотреть обстановку в 12-м сечении..

То, что мы сделали это без труда, не делает положение менее

серьезным: мы хорошо понимаем, что имеем дело с простейшим

примером, лишь намекающим на реальные сложности. Важен один

вывод: хотя по-прежнему единственной предпосылкой к

определению конкурентности для нас является информация о том,

принадлежит ли оператор, начинающий информационную связь,

маршруту другой связи, итоговый, так сказать, вывод о том,

■с какими связками конкурирует данная, делается более сложным

образом. Нам нужно теперь делать вышеупомянутую «проверку

на принадлежность» для всех результатов, входящих в данную

связку. Именно так мы поступали в 9-м и 10-м сечениях.

Углубленное представление. Поразмышляв над сделанным

выводом, а также над примером в целом, мы можем заключить, что

наши представления о проблеме экономии памяти существенно

расширились. Организуем по этому поводу нечто вроде

промежуточного финиша.

Для каждой информационной связи существуют реализующие

эту связь маршруты — цепочки операторов, начальный из

которых вырабатывает некоторую величину в качестве результата,

последний воспринимает эту величину и ни один из-внутренних

(т.е. между начальным и конечным) не вырабатывает эту величину.

Одна связь может реализоваться по нескольким маршрутам.

Информационные связи образуют связки, т. е. такие группы

«связей, которые смыкаются друг с другом своими концами,—

аргументами или результатами операторов. BcfeM аргументам и

результатам операторов, попадающим в одну связку, при

любом распределении памяти должна сопоставляться одна и та

же величина.

(Прочитав этот абзац еще раз, мы поймем, что понятие связки

у нас пока что какое-то приблизительное. В случае линейных

программ оно было точным: это — все связи, начинаемые одним

результатом. В общем случае оно еще подлежит точной

формулировке.) На первый взгляд, можно было бы сказать, что к связке

относятся все информационные связи, «концам» которых в

исходной схеме была сопоставлена одна и та же величина. Однако, уже

в только что рассмотренном примере мы, между прочим,

столкнулись с тем, что информационные связи, осуществленные в

исходной схеме через величину £1, распались совершенно четко на две

связки: одна с маршрутами (£1, £2, дис) и (£1, £2, due, p, q) и другая

с одним маршрутом (£1, кор\). Это само по себе не ново. Например,

каждый из маршрутов (G, Я), (Я, /), (/, /) и (/, К) на рис. 1.3, а)

реализует информационные связи, попадающие в разные связки,

36 ГЛ. i. СОДЕРЖАТЕЛЬНЫЙ АНАЛИЗ ЗАДАЧИ

хотя и имеющие общие операторы. Новым же оказалось то, что

стремление к наиболее экономному распределению памяти в

соответствии с принятой нами процедурой привело к тому, что этим

двум связкам (ti иН') были сопоставлены разные величины а и Ь*

Мы видим тем самым, что задача экономного распределения

памяти не может быть поставлена в такой, можно сказать, наивной

формулировке: «натолкать» как можно больше исходных величин

программы в одну ячейку. Пример 9 подсказывает, что «единицей»

распределения памяти является не вся «область действия»

исходной величины, а отдельные связки информационных связей,

осуществляемых через нее.

Возвращаясь к использованной процедуре экономного

распределения памяти, мы видим, что она, прежде всего, усложнилась.

Ьо-первых, более сложно строятся сечения. Смысл сечения

теперь выглядит следующим образом: мы рассекаем в месте

оператора S те и только те информационные связи, для которых

реализующие их маршруты содержат в себе S в качестве начального

или внутреннего операторов.

Во-вторых, анализ одного сечения недостаточен для

правильного определения, с какими информационными связями может

конкурировать связь, начинаемая результатом г оператора Sz

нужно проверить сечения, проведенные для всех операторов,

вырабатывающих результаты, входящих в ту же связку, что и

результат г.

Сечение, по-прежнему, нам показывает, какие величины за-г

няты в момент выполнения данного оператора, но уже не дает

возможности заключить, что все остальные величины в этот момент

свободны в том смысле, что их можно занимать новым результатом.

В-третьих, сама процедура утратила свою однозначную

направленность. Имея в программе разветвления, мы можем по-

разному обходить цепочки операторов. В примере 9, например,

мы могли бы сначала обходить правую цепочку (сечения 11—13),

а лишь потом левую (сечения 7—10). И хотя в данном случае мы

получим те же четыре величины (читатель может в этом

поупражняться), подсказанные нам сечением 12, тем не менее

доказательством того, что процедура дает всегда минимальное число

величин, мы в общем случае, включающем разветвления, уже не

располагаем.

Программа с циклами. Следующим шагом в нашем

содержательном анализе задачи будет исследование программ,

содержащих циклы.

Π ρ и м е ρ 10. Вычислить величину а по рекуррентному

соотношению

·, TCefen=ln(|tg(an_i)|).

§ 1.3. НАКОПЛЕНИЕ ФАКТОВ. ПРОГРАММЫ ОБЩЕГО ВИДА 37

Даны а0 и Ь0, а также условие на окончание: |&п| < 0.1.

Программа получается буквально по исходным формулам.

начало вещ а, Ь, с, dt e;

ввод (а, Ь);

повторение: с:== tg (a);

d: = Ъ + с;

е:= abs (с);

а:= d/e;

Ъ:— In (e);

если abs (b) ^0.1 то на повторение;

вывод (а)

конец

Построим операторную схему и проведем информационные

связи. Сечений и величин здесь не много, поэтому мы для экономии

места нанесем их на один и тот же чертеж (рис. 1.7). Читателю

Рис. 1.7. Операторная схема, содержащая цикл.

же мы советуем, как и раньше, перерисовать схему и

информационные связи для того, чтобы самому воспроизвести работу

процедуры экономии памяти. Обращаем внимание, что ширина каждого

сечения в схеме не превышает двух. Еще раз проследим работу

83

ГЛ. 1. СОДЕРЖАТЕЛЬНЫЙ АНАЛИЗ ЗАДАЧИ

процедуры во всех деталях (в качестве новых величин будем брать

а, Ь и т. д.).

Сечение 1. Два новых результата а и Ъ. Разносим эти

имена но всем аргументам и результатам соответствующих связок:

а на аргумент тангенса (tg), от него на результат деления (/), а от

последнего «а аргумент выв; Ъ на аргумент сложения (+)> от него

на результат логарифма (In), а от последнего на аргумент

сравнения (<).

Сечение 2. Новый результат. Конкурирует с Ъ. Берем а,

сопоставляем результату и разносим на аргумент сложения и

вычисления abs.

Сечение 3. Новый результат. Конкурирует с а. Берем Ь,

сопоставляем результату и разносим на аргумент деления.

Сечение 4. Новый результат. Его связка конкурирует

как с а, так и с Ь. Берем с, сопоставляем результату и разносим

на аргумент деления и вычисления In.

После этого все позиции аргументов и результатов заняты

величинами, так что остальные сечения просматривать

незачем.

Трудности с сечением. На первый взгляд в четвертом сечении

мы имеем ту же ситуацию, что и в девятом сечении примера 9.

Там у нас связка κορί оказалась конкурирующей со связкой q

(новое имя а), связкой дис (новое имя с) и связкой ρ (новое имя Ь),

и мы взяли еще одну величину d. Разница, однако, в следующем.

В примере 7 все эти связки оказываются конкурирующими также

и друг с другом, так что какие бы имена величин мы ни выбрали,

нам обязательно потребуются 4 величины. В рассматриваемом же

примере мы обнаруживаем, что связка результата оператора aba

конкурирует со связками результатов операторов сложения

(величина Ъ) и деления (величина а), хотя последние две связки друг

с другом не конкурируют. Таким образом, необходимость введения

третьей величины выглядит какой-то недостоверной. Может быть,

при другом порядке распределения памяти мы могли бы этим

связкам сопоставить одинаковые величины и тогда все-таки обойтись

двумя величинами, на что нас, казалось бы, наталкивает ширина

сечений, как мы уже заметили, нигде не превышающая двух.

С другой стороны, нам с определенностью кажется, что при

распределении памяти мы в любой момент поступали единственно

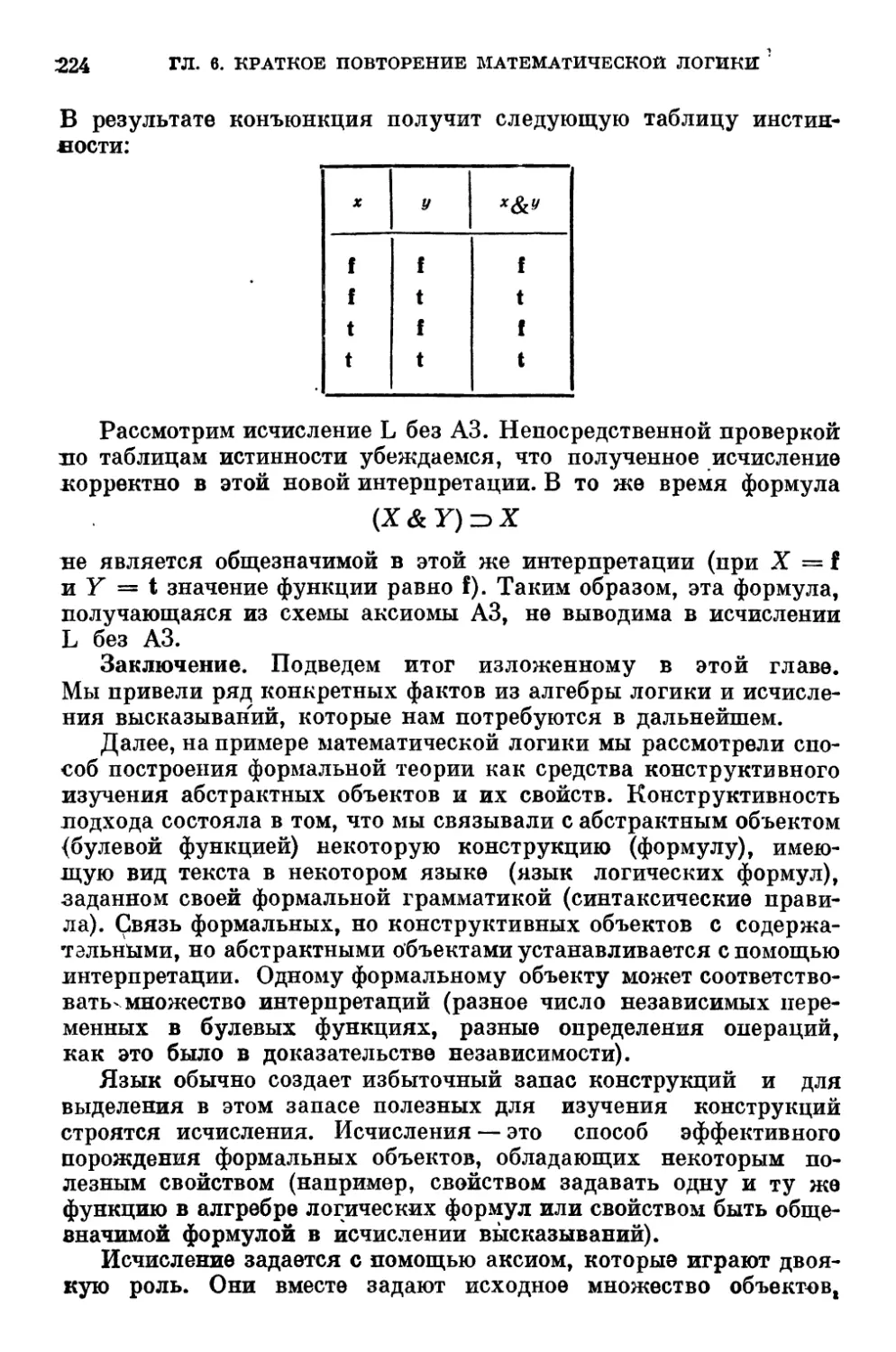

возможным образом, и читатель вправе предположить, что здесь