Текст

Основы многопоточного,

параллельного

и распределенного

программирования

Foundations of Multithreaded,

Parallel, and Distributed

Programming

GREGORY R. ANDREWS

University of Arizona

ADDISON-WESLEY

An imprint of Addison Wesley Longman, Inc.

Reading, Massachusetts Menlo Park, California

Ney York • Harlow, England • Don Mills, Ontario

Sydney • Mexico City * Madrid • Amsterdam

Основы многопоточного,

параллельного

и распределенного

программирования

ГРЕГОРИ Р. ЭНДРЮС

Университет штата Аризона

Москва • Санкт-Петербург • Киев

2003

ББК 32.973.26-018.2.75

Э64

УДК 681.3.07

Издательский дом “Вильямс”

Зав. редакцией А.В. Слепцов

Перевод с английского А.С. Подосельника, Г.И. Сингаевской,

канд.физ.-мат.наукЛ.Б. Ставровского

Под редакцией канд.физ.-мат.наукЛ.Б. Ставровского

По общим вопросам обращайтесь в Издательский дом “Вильямс” по адресу:

info@williamspublishing.com, http://www.williamspublishing.com

Эвдрюс Г.Р.

Э64 Основы многопоточного, параллельного и распределенного программирования. :

Пер. с англ. — М.: Издательский дом “Вильямс”, 2003. — 512 с.: ил. — Парал. тит. англ.

ISBN 5-8459-0388-2 (рус.)

В книге рассматриваются важнейшие концепции многопоточного, параллельного и рас-

пределенного программирования, которые должен знать каждый программист, создающий

программное обеспечение подобного типа. Все обсуждаемые концепции и методы тща-

тельно проиллюстрированы многочисленными примерами, написанными на основных

языках программирования с использованием наиболее распространенных библиотек. Об-

суждение каждого учебного примера включает описание соответствующих элементов ис-

пользуемого языка или библиотеки и содержит полный текст прикладной программы.

В книге освещаются общие механизмы параллельного программирования с использова-

нием разделяемых переменных, основные концепции распределенного программирования

и механизмы взаимодействия и синхронизации процессов с помощью обмена сообщениями.

Заключительная часть книги посвящена обсуждению применения методов параллельного

программирования при проведении сложных научных вычислений.

Книга может быть полезна как студентам, изучающим соответствующие курсы, так

и специалистам-практикам в области разработки программного обеспечения.

ББК 32.973.26-018.2.75

Все названия программных продуктов являются зарегистрированными торговыми марками соответ-

ствующих фирм.

Никакая часть настоящего издания ни В каких целях не может быть воспроизведена в какой бы то

ни было форме и какими бы то ни было средствами, будь то электронные или механические, включая

фотокопирование и запись на магнитный носитель, если на это нет письменного разрешения изда-

тельства Addison Wesley Longman, Inc.

Authorized translation from the English language edition published by Addison Wesley Longman, Inc.,

Copyright © 2000

All rights reserved. No part of this book may be reproduced or transmitted in any form or by any means,

electronic or mechanical, including photocopying, recording or by any information storage retrieval system,

without permission from the Publisher.

Russian language edition published by Williams Publishing House according to the Agreement with R&I

Enterprises International, Copyright © 2003

ISBN 5-8459-0388-2 (pyc.)

ISBN 0-2013-5752-6 (англ.)

© Издательский дом “Вильямс”, 2003

© Addison Wesley Longman, Inc., 2000

Оглавление

Предисловие 13

Глава 1. Обзор области параллельных вычислений 47

ЧАСТЬ 1

ПРОГРАММИРОВАНИЕ С РАЗДЕЛЯЕМЫМИ ПЕРЕМЕННЫМИ 47

Глава 2. Процессы и синхронизация 49

Глава 3. Блокировки и барьеры 87

Глава 4. Семафоры 131

Глава 5. Мониторы 168

Глава 6. Реализация 213

ЧАСТЬ 2

РАСПРЕДЕЛЕННОЕ ПРОГРАММИРОВАНИЕ 233

Глава 7. Передача сообщений 236

Глава 8. Удаленный вызов процедур и рандеву 283

Глава 9. Модели взаимодействия процессов 328

Глава 10. Реализация языковых механизмов 375

ЧАСТЬ 3

СИНХРОННОЕ ПАРАЛЛЕЛЬНОЕ ПРОГРАММИРОВАНИЕ 403

Глава 11. Научные вычисления 408

Глава 12. Языки, компиляторы, библиотеки и инструментальные

средства 449

Словарь 489

Предметный указатель 496

Содержание

Предисловие 13

Глава 1. Обзор области параллельных вычислений 47

1.1. Суть параллельного программирования 47

1.2. Структуры аппаратного обеспечения 47

1.2.1. Процессоры и кэш-память 47

1.2.2. Мультипроцессоры с разделяемой памятью 47

1.2.3. Мультикомпьютеры с распределенной памятью и сети 47

1.3. Приложения и стили программирования 47

1.4. Итеративный параллелизм: умножение матриц 47

1.5. Рекурсивный параллелизм: адаптивная квадратура 47

1.6. Производители и потребители: каналы ОС Unix 47

1.7. Клиенты и серверы: файловые системы 47

1.8. Взаимодействующие равные: распределенное умножение матриц 47

1.9. Обзор программной нотации 47

1.9.1. Декларации 47

1.9.2. Последовательные операторы 47

1.9.3. Параллельные операторы, процессы и процедуры 47

1.9.4. Комментарии 47

Историческая справка 47

Литература 47

Упражнения 47

ЧАСТЬ 1. ПРОГРАММИРОВАНИЕ С РАЗДЕЛЯЕМЫМИ

ПЕРЕМЕННЫМИ 47

Глава 2. Процессы и синхронизация 49

2.1. Состояние, действие, история и свойства 49

2.2. Распараллеливание: поиск образца в файле 51

2.3. Синхронизация: поиск максимального элемента массива 54

2.4. Неделимые действия и операторы ожидания 56

2.4.1. Мелкомодульная неделимость 56

2.4.2. Задание синхронизации: оператор ожидания 58

2.5. Синхронизация типа “производитель-потребитель” 60

2.6. Обзор аксиоматической семантики 61

2.6.1. Формальные логические системы 61

2.6.2. Логика программирования 62

2.6.3. Семантика параллельного выполнения 65

2.7. Техника устранения взаимного вмешательства 67

2.7.1. Непересекающиеся множества переменных 67

2.7.2. Ослабленные утверждения 68

2.7.3. Глобальные инварианты 69

2.7.4. Синхронизация 70

Содержание

7

2.7.5. Пример: еще раз о задаче копирования массива 70

2.8. Свойства безопасности и живучести 72

2.8.1. Доказательство свойств безопасности 73

2.8.2. Стратегии планирования и справедливость 74

Историческая справка 76

Литература 78

Упражнения 79

Глава 3. Блокировки и барьеры 87

3.1. Задача критической секции 88

3.2. Критические секции: активные блокировки 90

3.2.1. “Проверить-установить” 91

3.2.2. “Проверить-проверить-установить” 92

3.2.3. Реализация операторов await 93

3.3. Критические секции: решения со справедливой стратегией 95

3.3.1. Алгоритм разрыва узла 95

3.3.2. Алгоритм билета 99

3.3.3. Алгоритм поликлиники 101

3.4. Барьерная синхронизация 103

3.4.1. Разделяемый счетчик 104

3.4.2. Флаги и управляющие процессы 105

3.4.3. Симметричные барьеры 108

3.5. Алгоритмы, параллельные по данным 110

3.5.1. Параллельные префиксные вычисления 110

3.5.2. Операции со связанными списками 112

3.5.3. Сеточные вычисления: итерация Якоби 114

3.5.4. Синхронные мультипроцессоры 115

3.6. Параллельные вычисления с портфелем задач 116

3.6.1. Умножение матриц 116

3.6.2. Адаптивная квадратура 117

Историческая справка 119

Литература 121

Упражнения 122

Глава 4. Семафоры 131

4.1. Синтаксис и семантика 131

4.2. Основные задачи и методы 133

4.2.1. Критические секции: взаимное исключение 133

4.2.2. Барьеры: сигнализирующие события 134

4.2.3. Производители и потребители: разделенные двоичные семафоры 135

4.2.4. Кольцевые буферы: учет ресурсов 136

4.3. Задача об обедающих философах 139

4.4. Задача о читателях и писателях 141

4.4.1. Задача о читателях и писателях как задача исключения 141

4.4.2. Решение задачи о читателях и писателях с использованием условной

синхронизации 143

4.4.3. Метод передачи эстафеты 145

4.4.4. Другие стратегии планирования 147

4.5. Распределение ресурсов и планирование 149

8

Содержание

4.5.1. Постановка задачи и общая схема решения 150

4.5.2. Распределение ресурсов по схеме “кратчайшее задание” 151

4.6. Учебные примеры: библиотека Pthreads 154

4.6.1. Создание потока 154

4.6.2. Семафоры 155

4.6.3. Пример: простая программа типа “производитель-потребитель” 156

Историческая справка 157

Литература 158

Упражнения 159

Глава 5. Мониторы 168

5.1. Синтаксис и семантика 169

5.1’. 1. Взаимное исключение 170

5.1.2. Условные переменные 170

5.1.3. Дисциплины сигнализации 171

5.1.4. Дополнительные операции с условными переменными 174

5.2. Методы синхронизации 175

5.2.1. Кольцевые буферы: базовая условная синхронизация 175

5.2.2. Читатели и писатели: сигнал оповещения 176

5.2.3. Распределение ресурсов по схеме “кратчайшее задание”:

приоритетное ожидание 178

5.2.4. Интервальный таймер: покрывающие условия 179

5.2.5. Спящий парикмахер: рандеву 181

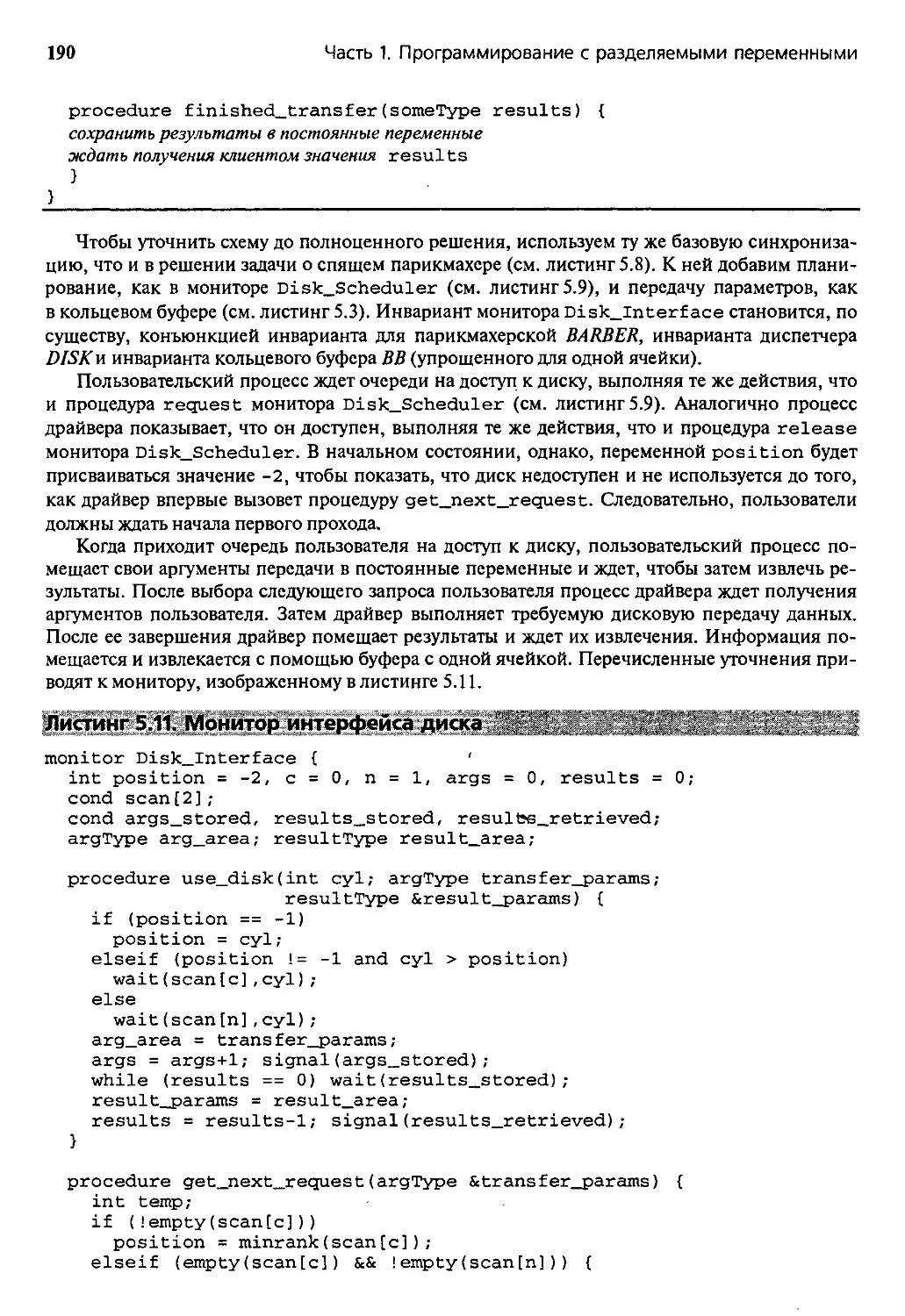

5.3. Планирование работы диска: программные структуры 184

5.3.1. Использование отдельного монитора 186

5.3.2. Использование посредника 188

5.3.3. Использование вложенного монитора 191

5.4. Учебные примеры: язык Java 193

5.4.1. Класс потоков 193

5.4.2. Синхронизированные методы 194

5.4.3. Читатели и писатели с параллельным доступом 195

5.4.4. Читатели и писатели с исключительным доступом 197

5.4.5. Подлинная задача о читателях и писателях 198

5.5. Учебные примеры: библиотека Pthreads 199

5.5.1. Блокировки и условные переменные 200

5.5.2. Пример: суммирование элементов матрицы 200

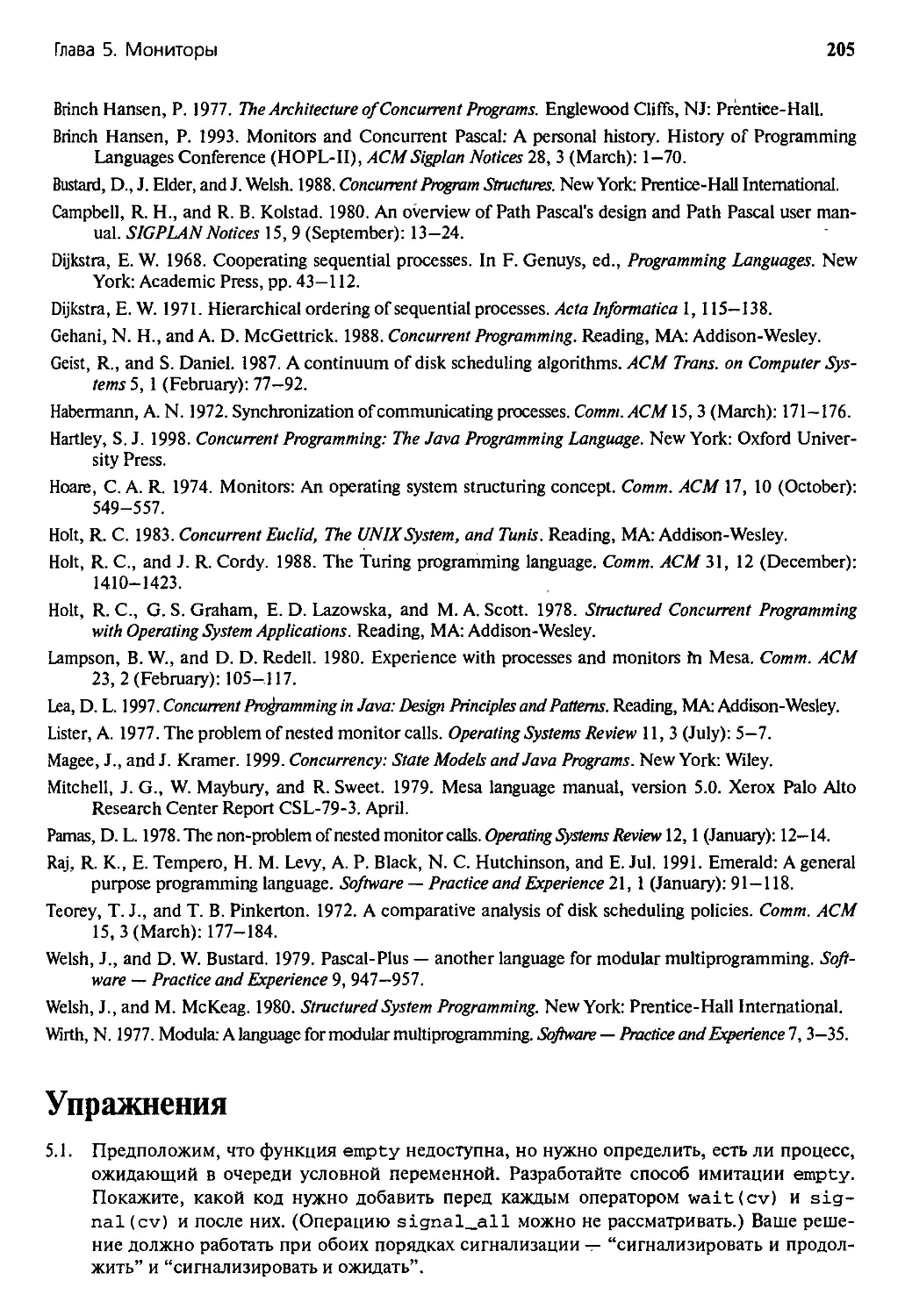

Историческая справка 202

Литература 204

Упражнения 205

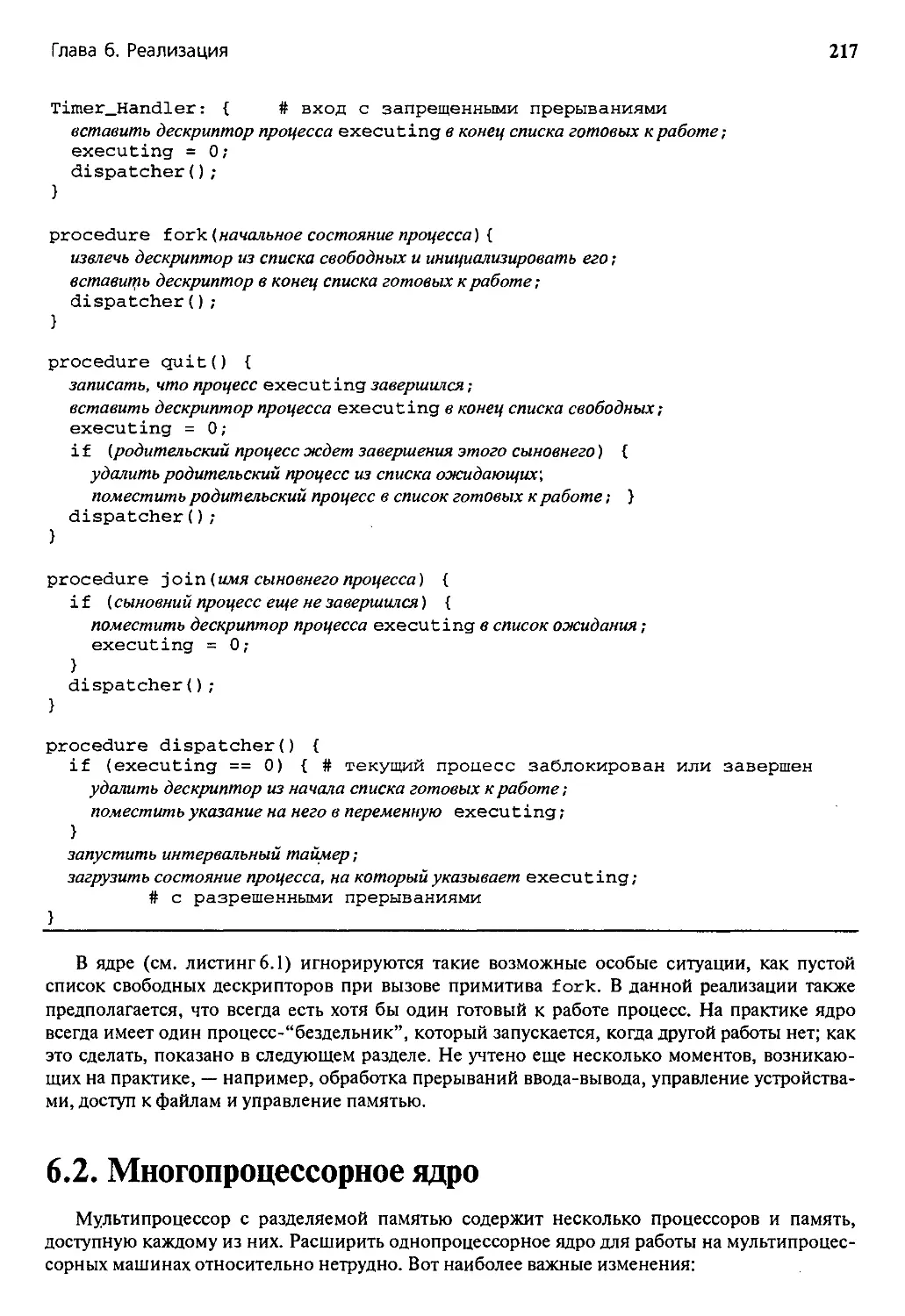

Глава 6. Реализация 213

6.1. Однопроцессорное ядро 213

6.2. Многопроцессорное ядро 217

6.3. Реализация семафоров в ядре 222

6.4. Реализация мониторов в ядре 224

6.5. Реализация мониторов с помощью семафоров 226

Историческая справка 228

Литература 229

Упражнения 230

Содержание

9

ЧАСТЬ 2. РАСПРЕДЕЛЕННОЕ ПРОГРАММИРОВАНИЕ 233

Глава 7. Передача сообщений 236

7.1. Асинхронная передача сообщений 236

7.2. Фильтры: сортирующая сеть 238

7.3. Клиенты и серверы 241

7.3.1. Активные мониторы 241

7.3.2. Планирующий сервер диска 245

7.3.3. Файловые серверы: непрерывность диалога 248

7.4. Взаимодействующие равные: обмен значений 249

7.5. Синхронная передача сообщений 252

7.6. Учебные примеры: CSP 254

7.6.1. Операторы взаимодействия 255

7.6.2. Защищенное взаимодействие 256

7.6.3. Пример: решето Эратосфена 258

7.6.4. Язык Occam и современная версия CSP 260

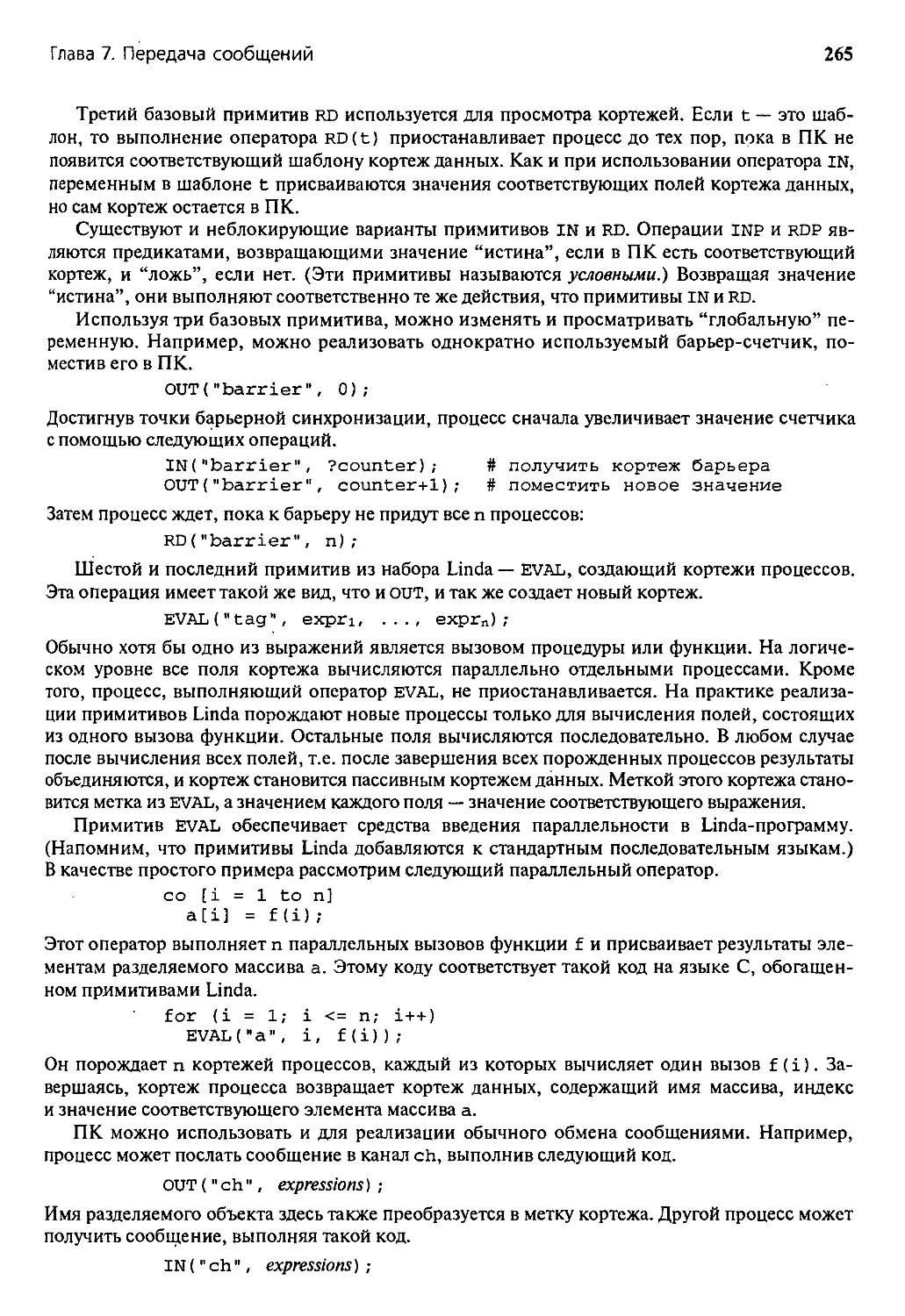

7.7. Учебные примеры: Linda 263

7.7.1. Пространство кортежей и взаимодействие процессов 264

7.7.2. Пример: генерация простых чисел с помощью портфеля задач 266

7.8. Учебные примеры: библиотека МР1 268

7.8.1. Базовые функции 268

7.8.2. Глобальное взаимодействие и синхронизация 270

7.9. Учебные примеры: язык Java 270

7.9.1. Сети и сокеты 271

7.9.2. Пример: удаленное чтение файла 271

Историческая справка 274

Литература 276

Упражнения 277

Глава 8. Удаленный вызов процедур и рандеву 283

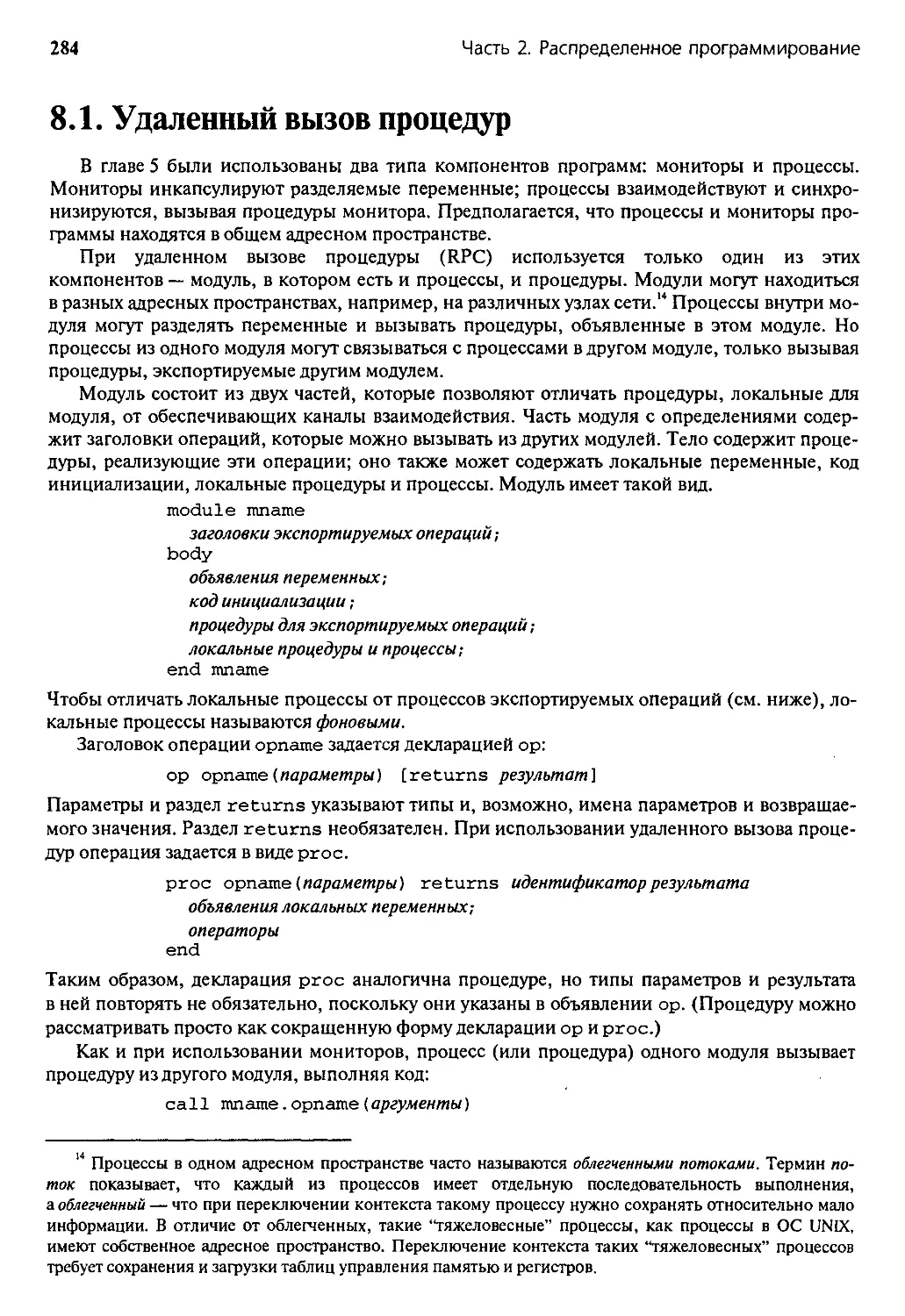

8.1. Удаленный вызов процедур 284

8.1.1. Синхронизация в модулях 285

8.1.2. Сервер времени 286

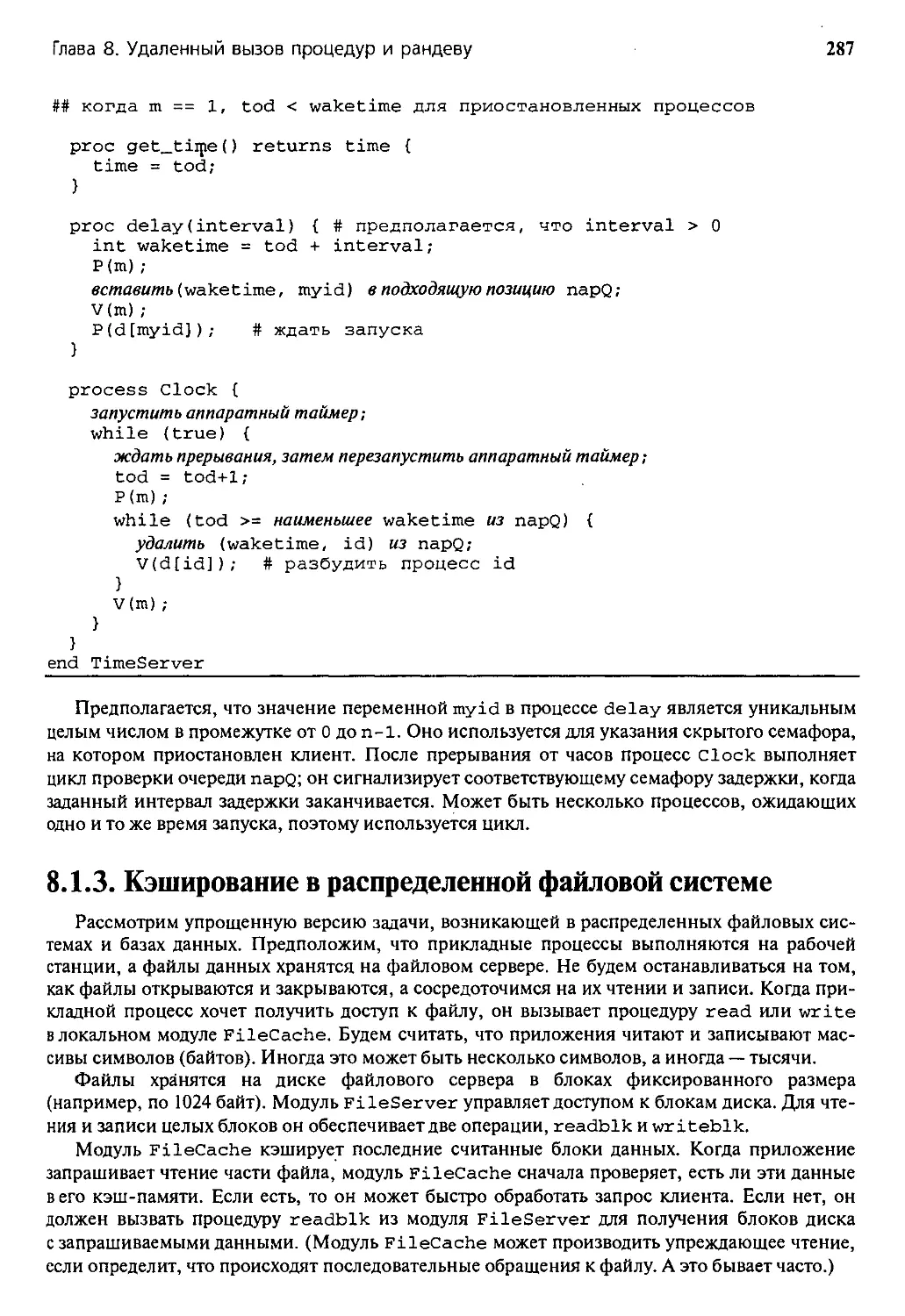

8.1.3. Кэширование в распределенной файловой системе 287

8.1.4. Сортирующая сеть из фильтров слияния 289

8.1.5. Взаимодействующие равные: обмен значений 291

8.2. Рандеву 292

8.2.1. Операторы ввода 292

8.2.2. Примеры взаимодействий типа “клиент-сервер” 294

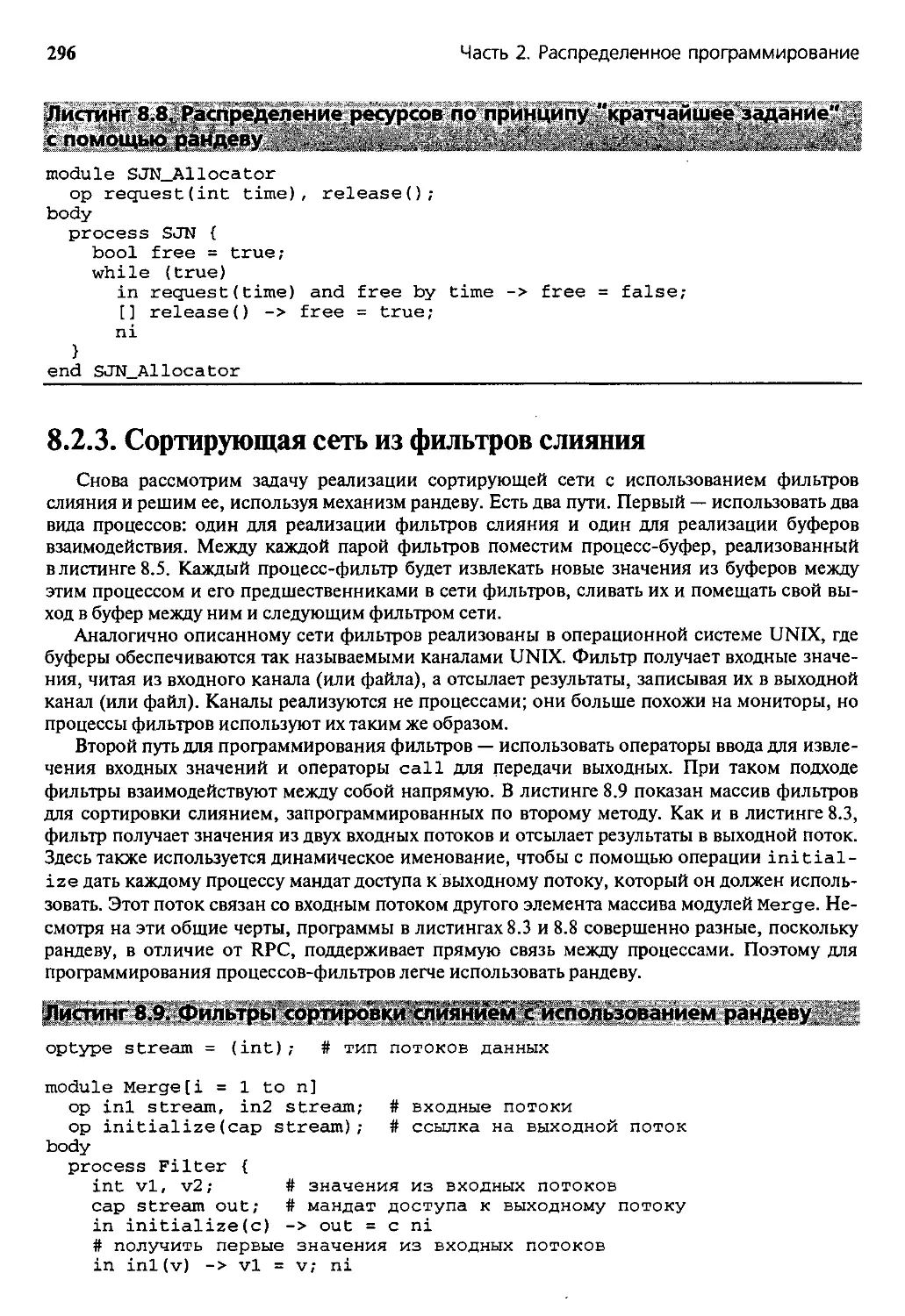

8.2.3. Сортирующая сеть из фильтров слияния 296

8.2.4. Взаимодействующие равные: обмен значений 297

8.3. Нотация совместно используемых примитивов 298

8.3.1. Вызов и обслуживание операций 298

8.3.2. Примеры 299

8.4. Новые решения задачи о читателях и писателях 301

8.4.1. Инкапсулированный доступ 301

8.4.2. Дублируемые файлы 303

8.5. Учебные примеры: язык Java 306

8.5.1. Удаленный вызов методов 306

10

Содержание

8.5.2. Пример: удаленная база данных 307

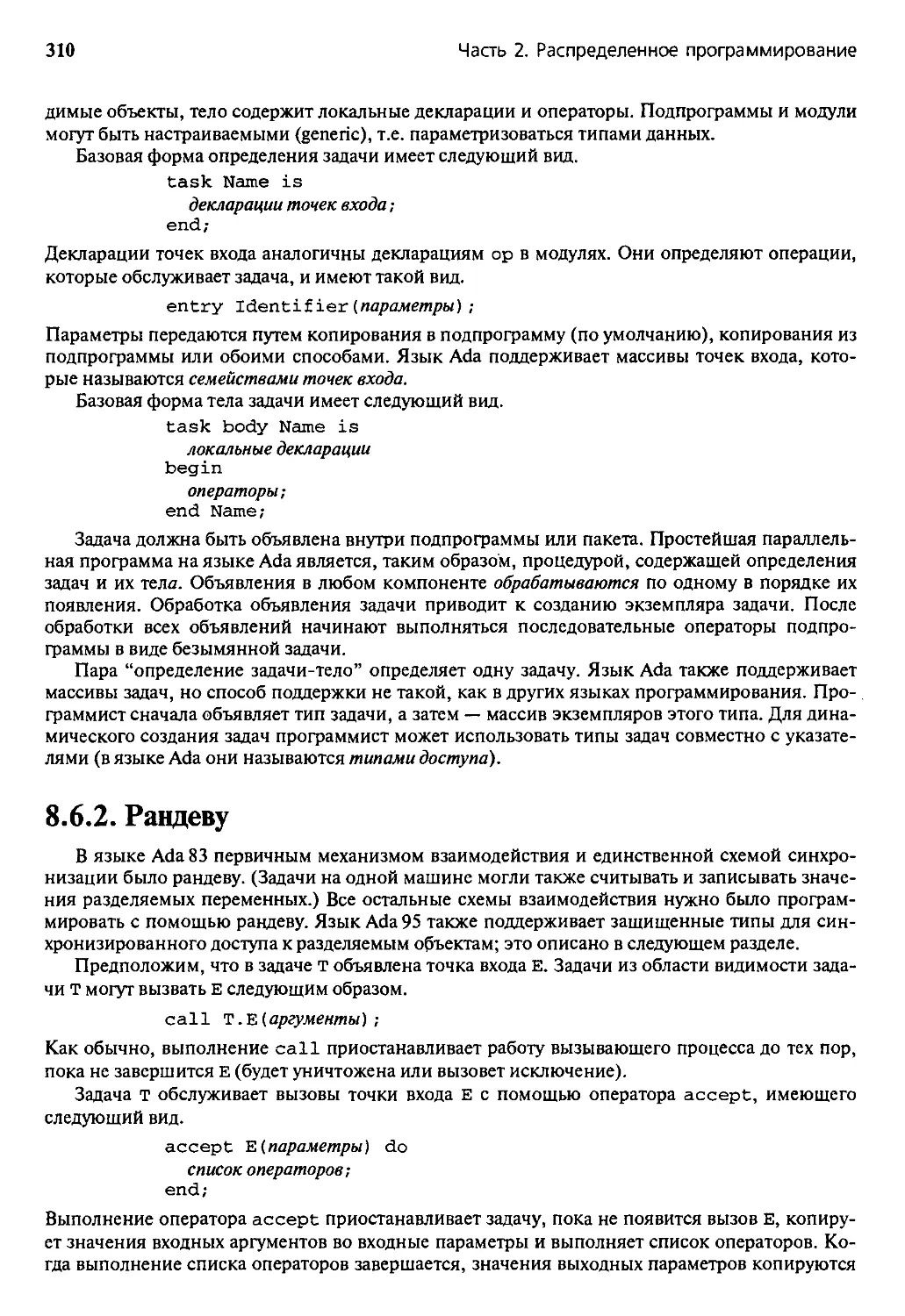

8.6. Учебные примеры: язык Ada 309

8.6.1. Задачи 309

8.6.2. Рандеву 310

8.6.3. Защищенные типы 312

8.6.4. Пример: обедающие философы 313

8.7. Учебные примеры: язык SR 315

8.7.1. Ресурсы и глобальные объекты 316

8.7.2. Взаимодействие и синхронизация 317

8.7.3. Пример: моделирование критической секции 318

Историческая справка 319

Литература 322

Упражнения 323

Глава 9. Модели взаимодействия процессов 328

9.1. Управляющий-рабочие (распределенный портфель задач) 328

9.1.1. Умножение разреженных матриц 329

9.1.2. Вернемся к адаптивной квадратуре 331

9.2. Алгоритмы пульсации 333

9.2.1. Обработка изображений: выделение областей 334

9.2.2. Клеточный автомат: игра “Жизнь” 337

9.3. Конвейерные алгоритмы 338

9.3.1. Конвейер для распределенного умножения матриц 339

9.3.2. Блочное умножение матриц 341

9.4. Алгоритмы типа “зонд-эхо” 343

9.4.1. Рассылка сообщений в сети 344

9.4.2. Построение топологии сети 346

9.5. Алгоритмы рассылки 348

9.5.1. Логические часы и упорядочение событий 349

9.5.2. Распределенные семафоры 350

9.6. Алгоритмы передачи маркера 353

9.6.1. Распределенное взаимное исключение 353

9.6.2. Как определить окончание работы в кольце 355

9.6.3. Определение окончания работы в графе 357

9.7. Дублируемые серверы 359

9.7.1. Распределенное решение задачи об обедающих философах 359

9.7.2. Децентрализованное решение задачи об обедающих философах 361

Историческая справка 363

Литература 365

Упражнения 367

Глава 10. Реализация языковых механизмов 375

10.1. Асинхронная передача сообщений 375

10.1.1. Ядро для разделяемой памяти 375

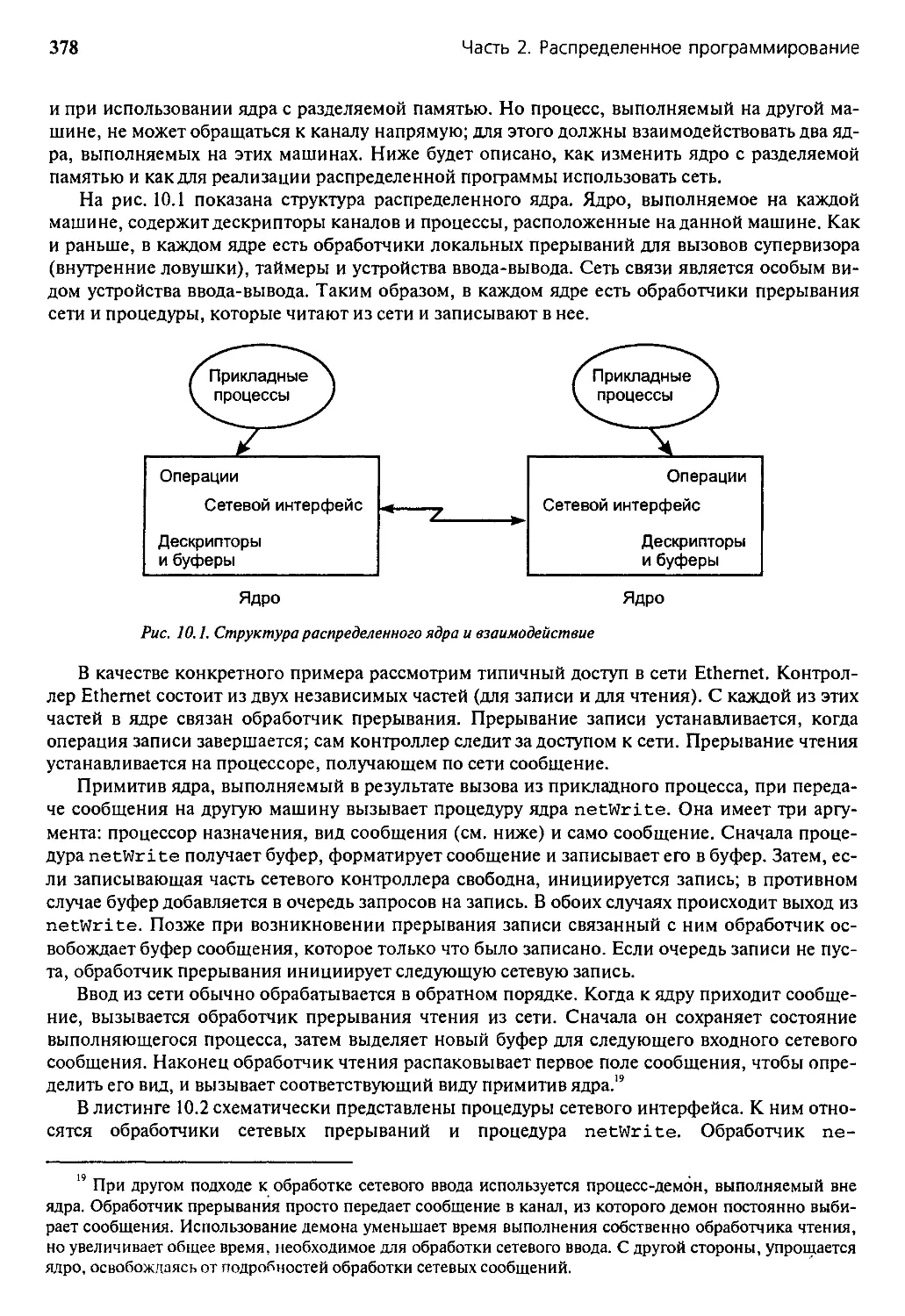

10.1.2. Распределенное ядро 377

10.2. Синхронная передача сообщений 381

10.2.1. Прямое взаимодействие с использованием асинхронных сообщений 382

10.2.2. Реализация защищенного взаимодействия с помощью учетного

процесса 383

Содержание

11

10.3. Удаленный вызов процедур и рандеву 387

10.3.1. Реализация RPC в ядре 387

10.3.2. Реализация рандеву с помощью асинхронной передачи сообщений 389

10.3.3. Реализация совместно используемых примитивов в ядре 391

10.4. Распределенная разделяемая память 395

10.4.1. Обзор реализации 396

10.4.2. Протоколы согласования страниц 398

Историческая справка 398

Литература 399

Упражнения 400

ЧАСТЬ 3. СИНХРОННОЕ ПАРАЛЛЕЛЬНОЕ

ПРОГРАММИРОВАНИЕ 403

Глава 11. Научные вычисления 408

11.1. Сеточные вычисления 408

11.1.1. Уравнение Лапласа 409

11.1.2. Метод последовательных итераций Якоби 409

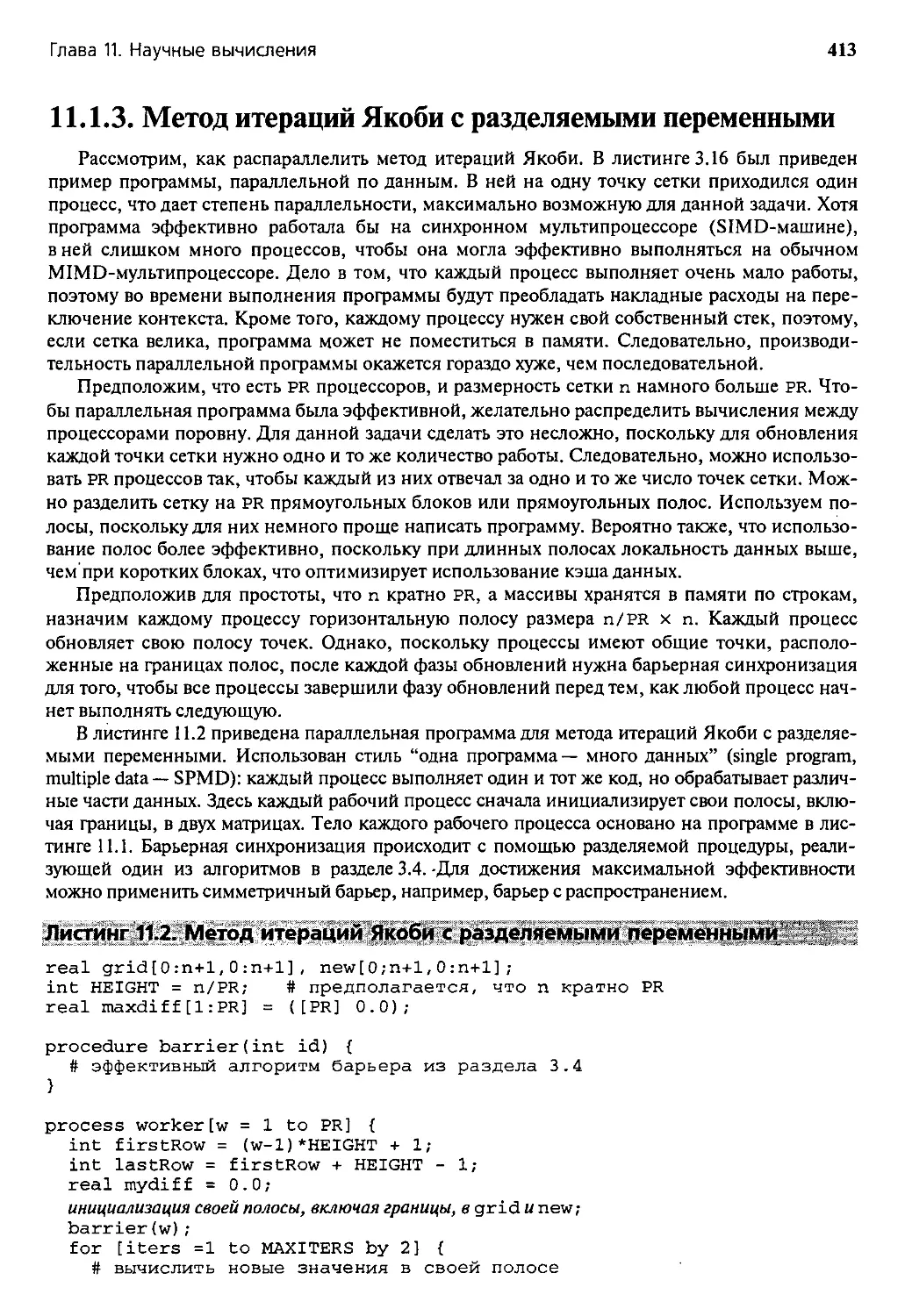

11.1.3. Метод итераций Якоби с разделяемыми переменными 413

11.1.4. Метод итераций Якоби с передачей сообщений 414

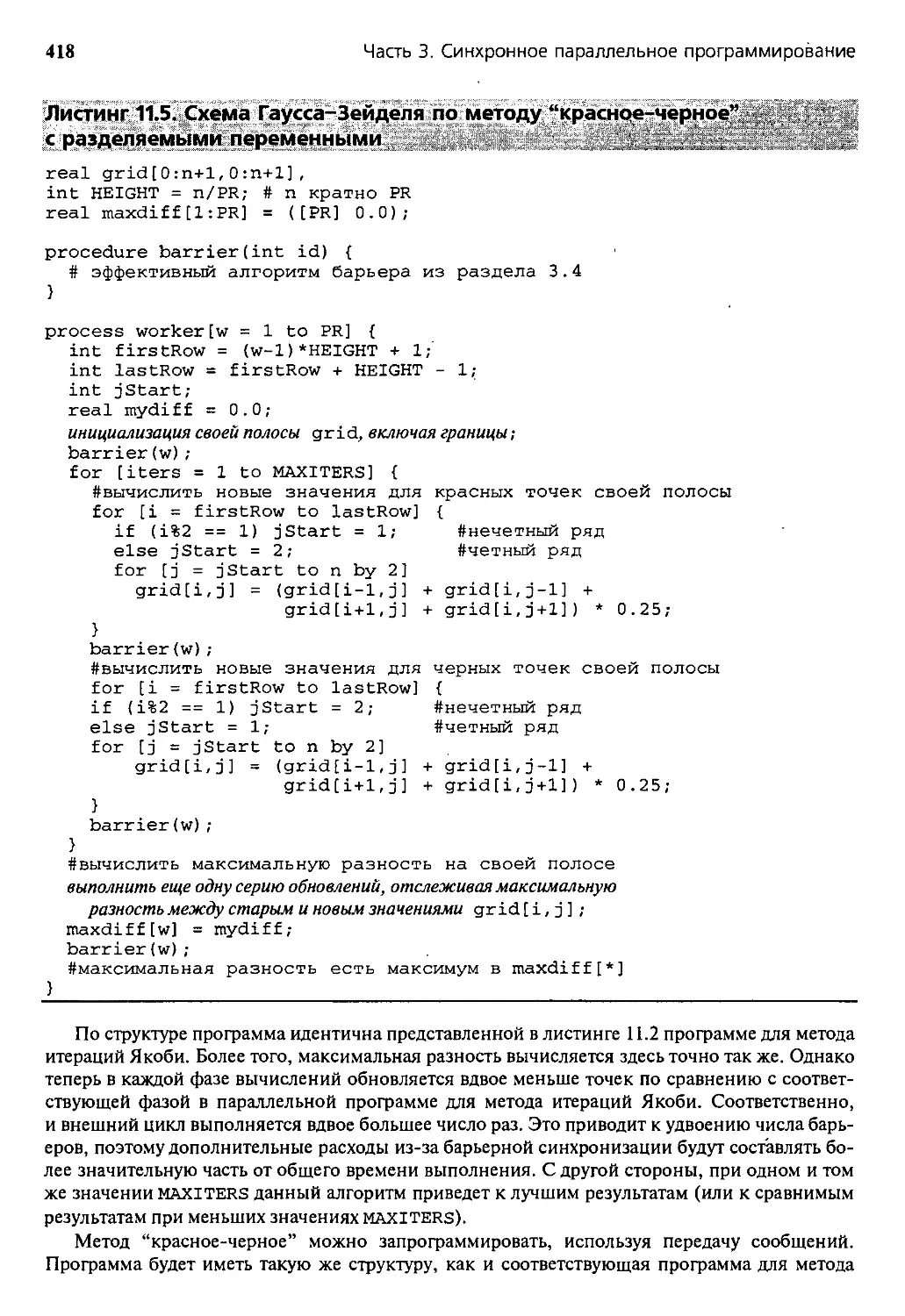

11.1.5. Последовательная сверхрелаксация по методу “красное-черное” 417

11.1.6. Многосеточные методы 419

11.2. Точечные вычисления 422

11.2.1. Гравитационная задача л тел 422

11.2.2. Программа с разделяемыми переменными 425

11.2.3. Программы с передачей сообщений 428

11.2.4. Приближенные методы 434

11.3. Матричные вычисления 436

11.3.1. Метод исключений Гаусса 436

11.3.2. LU-разложение 438

11.3.3. Программа с разделяемыми переменными 439

11.3.4. Программа с передачей сообщений 441

Историческая справка 443

Литература 444

Упражнения 445

Глава 12. Языки, компиляторы, библиотеки и инструментальные средства 449

12.1. Библиотеки параллельного программирования 450

12.1.1. Учебный пример: Pthreads 450

12.1.2. Учебный пример: MPI 452

12.1.3. Учебный пример: ОрепМР 454

12.2. Распараллеливающие компиляторы 458

12.2.1. Анализ зависимости 458

12.2.2. Преобразования программ 460

12.3. Языки и модели 466

12.3.1. Императивные языки 466

12.3.2. Языки с координацией 469

12.3.3. Языки с параллельностью по данным 470

12.3.4. Функциональные языки 472

12.3.5. Абстрактные модели 474

12 Содержание

12.3.6. Учебные примеры: быстродействующий Фортран (HPF) 476

12.4. Инструментальные средства параллельного программирования 479

12.4.1. Измерение и визуализация производительности 479

12.4.2. Метакомпьютеры и метавычисления 480

12.4.3. Учебные примеры: инструментальный набор Globus 481

Историческая справка 483

Литература 485

Упражнения 487

Словарь 489

Предметный указатель 496

Предисловие

Параллельное программирование возникло в 1962 г. с изобретением каналов — независи-

мых аппаратных контроллеров, позволявших центральному процессору выполнять новую

прикладную программу одновременно с операциями ввода-вывода других (приос-

тановленных) программ. Параллельное программирование (слово параллельное в данном слу-

чае означает “происходящее одновременно”1) первоначально было уделом разработчиков

операционных систем. В конце 60-х годов были созданы многопроцессорные машины. В ре-

зультате не только были поставлены новые задачи разработчикам операционных систем, но

и появились новые возможности у прикладных программистов.

Первой важной задачей параллельного программирования стало решение проблемы так

называемой критической секции. Эта и сопутствующие ей задачи (“обедающих философов”,

“читателей и писателей” и т.д.) привели к появлению в 60-ё годы огромного числа научных

работ. Для решения данной проблемы и упрощения работы программиста были разработаны

такие элементы синхронизации, как семафоры и мониторы. К середине 70-х годов стало яс-

но, что для преодоления сложности, присущей параллельным программам, необходимо ис-

пользовать формальные методы.

На рубеже 70-х и 80-х годов появились компьютерные сети. Для глобальных сетей стан-

дартом стал Arpanet, а для локальных— Ethernet. Сети привели к росту распределенного

программирования, которое стало основной темой в 80-х и, особенно, в 90-х годах. Суть рас-

пределенного программирования состоит во взаимодействии процессов путем передачи со-

общений, а не записи и чтения разделяемых переменных.

Сейчас, на заре нового века, стала заметной необходимость обработки с массовым парал-

лелизмом, при которой для решения одной задачи используются десятки, сотни и даже тыся-

чи процессоров. Также видна потребность в технологии клиент-сервер, сети Internet и World

Wide Web. Наконец, стали появляться многопроцессорные рабочие станции и ПК. Парал-

лельное аппаратное обеспечение используется больше, чем когда-либо, а параллельное про-

граммирование становится необходимым.

Это моя третья книга, в которой предпринята попытка охватить часть истории парал-

лельного программирования. Первая книга — Concurrent Programming: Principles and Practice,

опубликованная в 1991 г., — дает достаточно полное описание периода между 1960 и 1990

годами. Основное внимание в ней уделяется новым задачам, механизмам программирова-

ния и формальным методам.

Вторая книга— The SR Programming Language: Concurrency in Practice, опубликованная

в 1993 году, — подводит итог моей работы с Роном Олсоном (Ron Olsson) в конце 80-х и нача-

ле 90-х годов над специальным языком программирования, который может использоваться

при написании параллельных программ для систем как с разделяемой, так и с распределен-

ной памятью. Книга о языке SR является скорее практическим руководством, чем формаль-

ным описанием языка, поскольку демонстрирует пути решения многих проблем с использо-

ванием одного языка программирования.

Данная книга выросла из предыдущих и является отражением моих мыслей о том, что

важно сейчас и в будущем. Многое почерпнуто из книги Concurrent Programming, но полно-

стью переработан каждый раздел, взятый из нее, и переписаны все примеры программ на

псевдоС вместо языка SR. Все разделы дополнены новым материалом; особенно это каса-

1 Слово “параллельный” в большинстве случаев является переводом английского “concurrent”. При-

менительно к программам, вычислениям и программированию его смысл, возможно, лучше передавался

бы словом “многопроцессный”, но этого термина в русскоязычной литературе нет. Перевод английского

“parallel” связан с синхронным параллелизмом, и его смысл определяется в разделах 1.3 и 3.5 и уточняется

в самом начале части 3. Отметим, что смысл слова “concurrent” шире, чем “parallel”. — Прим. ред.

14

Предисловие

ется параллельного научного программирования. Также добавлены учебные примеры по

наиболее важным языкам программирования и библиотекам программ, содержащие завер-

шенные учебные программы. И, наконец, я по-новому вижу использование этой книги —

в аудиториях и личных библиотеках.

Новое видение и новая роль

Идеи параллельных и распределенных вычислений сегодня распространены повсеме-

стно. Как обычно в вычислительной технике, прогресс исходит от разработчиков аппарат-

ного обеспечения, которые создают все более быстрые, большие и мощные компьютеры

и коммуникационные сети. Большей частью, они достигают успеха, и лучшее доказатель-

ство тому — фондовая биржа!

Новые компьютеры и сети создают новые проблемы и возможности, а разработчики

программного обеспечения по-прежнему не отстают. Вспомните Web-броузеры, Internet-

коммерцию, потоки Pthread, язык Java, MPI, и вновь доказательством служит фондовая бир-

жа! Эти программные продукты разрабатываются специально для того, чтобы использовать

все преимущества параллельности в аппаратной и программной части. Короче говоря, боль-

шая часть мира вычислительной техники сейчас параллельна!

Аспекты параллельных вычислений — многопоточных, параллельных или распределен-

ных — теперь рассматриваются почти в каждом углубленном курсе по вычислительной тех-

нике. Отражая историю, курсы по операционным системам охватывают такие темы, как

многопоточность, протоколы взаимодействия и распределенные файловые системы. Курсы

по архитектуре вычислительной техники — многопроцессорность и сети, по компиляторам —

вопросы компиляции для параллельных машин, а теоретические курсы — модели параллель-

ной обработки данных. В курсах по алгоритмам изучаются параллельные алгоритмы, а по ба-

зам данных — блокировка и распределенные базы данных. В курсах по графике используется

параллелизм при визуализации и трассировке лучей. Этот список можно продолжить. Кроме

того, параллельные вычисления стали фундаментальным инструментом в широкой области

научных и инженерных дисциплин.

Главная цель книги, как видно из ее названия, — заложить основу для программирования

многопоточных, параллельных и распределенных вычислений. Частная цель — создать текст,

который можно использовать в углубленном курсе для студентов и магистров. Когда некото-

рая тема становится распространенной, как это произошло с параллелизмом, вводятся учеб-

ные курсы по ее основам. Аналогично, когда тема становится хорошо изученной, как сейчас

параллелизм, она переносится в нормативный курс.

Я пытался охватить те вопросы параллельной и распределенной обработки данных, кото-

рые, по моему мнению, должен знать любой студент, изучающий вычислительную технику.

Сюда включены основные принципы, методы программирования, наиболее важные прило-

жения, реализации и вопросы производительности. Я добавил также материал по важнейшим

языкам программирования и библиотекам программ — потоки Pthread (три главы), язык Java

(три главы), CSP, Linda, MPI (две главы), языки Ада, SR и ОрепМР. В каждом примере сна-

чала описаны соответствующие части языка программирования или библиотеки, а затем

представлена полная программа. Исходные тексты программ доступны на Web-сайте этой

книги. Кроме того, в главе 12 приведен обзор нескольких дополнительных языков, моделей и

инструментов для научных расчетов.

С другой стороны, ни в одной книге нельзя охватить все, поэтому, возможно, студенты и

преподаватели захотят дополнить данный текст. Исторические справки и списки литературы

в конце каждой главы описывают дополнительные материалы и содержат указания для даль-

нейшего изучения. Информация для дальнейшего изучения и ссылки на соответствующие

материалы представлены на Web-сайте этой книги.

Предисловие

15

Обзор содержания

Эта книга состоит из 12 глав. В главе 1 дается обзор основных идей параллелизма, аппарат-

ной части и приложений. Затем рассматриваются пять типичных приложений: умножение мат-

риц, адаптивная квадратура, каналы ОС Unix, файловые системы и распределенное умножение

матриц. Каждое приложение просто, но, тем не менее, полезно: вместе они иллюстрируют не-

который диапазон задач и пять стилей программирования многократных вычислений. В по-

следнем разделе главы 1 резюмируется программная нотация, использованная в книге.

Оставшиеся главы разделены на три части. Часть 1 описывает механизмы параллельного

программирования, которые используют разделяемые переменные и поэтому непосредст-

венно применяются к машинам с разделяемой памятью. В главе 2 представлены базовые по-

нятия процессов и синхронизации; основные моменты иллюстрируются рядом примеров. За-

канчивается глава обсуждением формальной семантики параллелизма. Понимание семанти-

ческих концепций поможет вам разобраться в некоторых разделах последующих глав.

В главе 3 показано, как реализовать и использовать блокировки и барьеры, описаны алгорит-

мы, параллельные по данным, и метод параллельного программирования, называемый

“портфель задач”. В главе 4 представлены семафоры и многочисленные примеры их исполь-

зования. Семафор был первым механизмом параллельного программирования высокого

уровня и остается одним из важнейших. В главе 5 подробно описаны мониторы. Они появи-

лись в 1974 г.; в 80-е и в начале 90-х годов внимание к ним несколько угасло, но появление

языка Java возобновило интерес к ним. Наконец, в главе 6 представлена реализация процес-

сов, семафоров и мониторов на одно- и многопроцессорных машинах.

Часть 2 посвящена распределенному программированию, в котором процессы взаимо-

действуют и синхронизируются, используя сообщения. В главе 7 описана передача сооб-

щений с помощью элементарных операций send и receive. Демонстрируется, как ис-

пользовать эти операции для программирования фильтров (программ с односторонней

связью), клиентов и серверов (с двусторонней связью), а также взаимодействующих рав-

ных (с передачей в обоих направлениях). В главе 8 рассматриваются два дополнительных

примитива взаимодействия: удаленный вызов процедуры (RPC) и рандеву. Процесс-

клиент инициирует связь, посылая сообщение call (неявно оно является последователь-

ностью сообщений send и receive). Взаимодействие обслуживается или новым процес-

сом (RPC), или с помощью рандеву с существующим процессом. В главе 9 описано не-

сколько моделей взаимодействия процессов в распределенных программах. Три из них

обычно используются в параллельных вычислениях — “управляющий-рабочие”, алгоритм

пульсации и конвейер. Еще четыре возникли в распределенных системах — зонд-эхо, опо-

вещение (рассылка), передача маркера и дублируемые серверы. Наконец, в главе 10 описа-

на реализация передачи сообщений, RPC и рандеву. Показано, как реализовать так назы-

ваемую распределенную разделяемую память, которая поддерживает модель программиро-

вания с разделяемой памятью в распределенной среде.

Часть 3 посвящена синхронному параллельному программированию, особенно его при-

менению к высокопроизводительным научным вычислениям. (Многие другие типы син-

хронных параллельных вычислений рассмотрены в предыдущих главах и в упражнениях к не-

скольким из них.) Цель параллельной программы — ускорение, т.е. более быстрое решение

задачи с помощью большого числа процессоров. Синхронные параллельные программы пи-

шутся с использованием разделяемых переменных или передачи сообщений, следовательно,

в них применяется методика, описанная в частях 1 и 2. В главе 11 рассматриваются три ос-

новных класса приложений для научных вычислений: сеточные, точечные и матричные. Они

возникают при моделировании физических и биологических систем; матричные вычисления

используются и для таких задач, как экономическое прогнозирование. В главе 12 дан обзор

наиболее важных инструментов для написания научных параллельных вычислительных

программ: библиотеки (Pthread, MPI, ОрепМР), распараллеливающие компиляторы, языки и

модели, а также такие инструменты более высокого уровня, как метавычисления.

16

Предисловие

В конце каждой главы размещены историческая справка, ссылки на литературу и упраж-

нения. В исторической справке резюмируются происхождение, развитие и связи каждой те-

мы с другими темами, а также описываются статьи и книги из списка литературы. В упражне-

ниях представлены вопросы, поднятые в главе, и дополнительные приложения.

Использование в учебном процессе

Я использую эту книгу каждой весной в университете штата Аризона, читая курс пример-

но для 60 студентов. Около половины из них — магистры; остальные — студенты старших

курсов. В основном это студенты специальности “computer science”. Данный курс для них не

обязателен, но большинство студентов его изучают. Также каждый год курс проходят не-

сколько аспирантов других отделений, интересующихся вычислительной техникой и парал-

лельными вычислениями. Большинство студентов одновременно проходят и наш курс по

операционным системам.

В наших курсах по ОС, как и везде, рассматриваются потребности ОС в синхронизации

и изучается реализация синхронизации, процессов и других элементов ОС, в основном, на од-

нопроцессорных машинах. Мой курс демонстрирует, как использовать параллельность в ка-

честве общего инструмента программирования для широкого диапазона приложений. Я рас-

сматриваю методы программирования, концепции высокого уровня, параллельную и распре-

деленную обработку данных. По существу, мой курс относится к курсу по ОС примерно так

же, как сравнительный курс языков программирования относится к курсу по компиляторам.

В первой половине моего курса я подробно излагаю главу 2, а затем быстро прохожу по

остальным главам первой части, акцентируя внимание на темах, не рассматриваемых

в курсе по ОС, — протокол “проверить-проверить-установить” (Test-and-Test-and-Set),

алгоритм билета, барьеры, передача эстафеты для семафоров, некоторые способы про-

граммирования мониторов и многопроцессорное ядро. В дополнение к этому студенты са-

мостоятельно изучают библиотеку Pthread, потоки языка Java и синхронизированные ме-

тоды. После лекций по барьерам они выполняют проект по синхронным параллельным

вычислениям (на основе материала главы 11).

Во второй половине курса я использую многое из материала части 2 книги, касающегося

распределенного программирования. Мы рассматриваем передачу сообщений и ее использо-

вание в программировании как распределенных систем, так и распределенных параллельных

вычислений. Затем мы изучаем RPC и рандеву, их воплощение в языках Java и Ada и прило-

жения в распределенных системах. Наконец, мы рассматриваем каждую парадигму из гла-

вы 9, вновь используя для иллюстрации и мотивировки приложения из области синхронных

параллельных и распределенных систем. Самостоятельно студенты изучают библиотеку MPI

и снова используют язык Java.

В течение семестра я даю четыре домашних задания, два аудиторных экзамена, проект по

параллельным вычислениям и заключительный проект. (Примеры представлены на Web-

сайте книги.) Каждое домашнее задание состоит из письменных упражнений и одной или

двух задач по программированию. Магистры должны выполнить все упражнения, другие сту-

денты — две трети задач (по своему выбору). Экзамены проводятся аналогично: магистры

решают все задачи, а остальные выбирают вопросы, на которые хотят отвечать. В Аризонском

университете начальные задачи по программированию мы решаем с помощью языка SR, ко-

торый студенты могут использовать и в дальнейшем, но поощряется использование таких

языков и библиотек, как Pthreads, Java и MPI.

Проект по синхронному параллельному программированию связан с задачами из главы 11

(обычно это сеточные вычисления). Студенты пишут программы и экспериментируют на не-

большом мультипроцессоре с разделяемой памятью. Магистры реализуют более сложные

алгоритмы и обязаны написать подробный отчет о своих опытах. Заключительный проект —

это статья или программный проект по какому-либо вопросу распределенного программиро-

вания. Студенты выбирают тему, которую я утверждаю. Большинство студентов выполняют

Предисловие

17

проекты по реализации, многие из них работают парами. Студенты создают разнообразные

интересные системы, в основном, с графическим интерфейсом.

Несмотря на то что студенты, изучающие мой курс, имеют различную подготовку, поч-

ти все оценивают его отлично. Студенты часто отмечают, насколько хорошо курс согласу-

ется с их курсом по ОС; им нравится взгляд на параллельность с другой точки зрения, изу-

чение многопроцессорных систем, им интересно рассматривать широкий спектр приложе-

ний и инструментов. Магистры отмечают, что курс связывает воедино разные вещи,

о которых они уже что-то слышали, и вводит их в область параллельного программирова-

ния. Однако многим из них было бы интересно изучить параллельные вычисления более

подробно. Со временем мы надеемся сделать отдельные курсы для магистров и студентов.

Я не буду значительно изменять курс для студентов, но в нем будет меньше углубленных

тем. В курсе для магистров я буду тратить меньше времени на материал, с которым они уже

знакомы (часть 1), и больше времени посвящать синхронным параллельным приложениям

и инструментарию синхронных вычислений (часть 3).

Эта книга идеально подходит для курса, который охватывает область механизмов парал-

лельного программирования, средств и приложений. Почти все студенты смогут использо-

вать что-то из рассмотренного здесь, но не все будут заниматься только параллельной обра-

боткой данных, только распределенными системами или программировать только на языке

Java. Тем не менее книгу можно использовать и как пособие в более специализированных

курсах, например, в курсе синхронных параллельных вычислений, вместе с книгами по па-

раллельным алгоритмам и приложениям.

Информация в Internet

“Домашняя страничка” этой книги находится по адресу:

http://www.cs.arizona.edu/people/greg/mpdbook

На этом сайте есть исходные тексты программ из книги, ссылки на программное обеспече-

ние и информацию о языках программирования и библиотеках, описанных в примерах;

большое число других полезных ссылок. Также сайт содержит обширную информацию

о моем курсе в Аризонском университете, включая программу курса, конспекты лекций,

копии домашних заданий, проектов и экзаменационных вопросов. Информация об этой

книге также доступна по адресу:

http://www.awlonline.com/cs

Несмотря на мои усилия, книга, без сомнения, содержит ошибки, так что по этому адресу поя-

вится (уверен, что скоро) их список. Безусловно, в будущем добавятся и другие материалы.

Благодарности

Я получил множество полезных замечаний от читателей чернового варианта этой книги.

Марти Тиенари (Martti Tienary) и его студенты из университета Хельсинки обнаружили не-

сколько неочевидных ошибок. Мои последние аспиранты, Винс Фрих (Vince Freeh) и Дейв

Ловентал (Dave Lowenthal), прокомментировали новые главы и за последние несколько лет

помогли отладить если не мои программы, то мои мысли. Студенты, изучавшие мой курс

весной 1999 г., служили “подопытными кроликами” и нашли несколько досадных ошибок.

Энди Бернат (Andy Bemat) предоставил отзыв о своем курсе в университете в Эль-Пасо, Те-

хас, который он провел весной 1999 г. Благодарю следующих рецензентов за их бесценные от-

зывы: Джаспал Субхлок (Jaspal Subhlok) из университета Camegy Mellon, Болеслав Жимански

(Boleslaw Szymansky) из политехнического института Rensselaer, Дж. С. Стайлс (G. S. Stiles) из

Utah State University, Нарсингх Део (Narsingh Deo) из Central Florida University, Джанет Харт-

ман (Janet Hartman) из Illinois State University, Нэн Шаллер (Nan C. Schaller) из Технологиче-

ского института Рочестера и Марк Файнап (Mark Fineup) из университета Северной Айовы.

В течение многих лет организация National Science Foundation поддерживает мои иссле-

дования, в основном по грантам CCR-9415303 и ACR-9720738. Грант от NSF (CDA-9500991)

помог обеспечить оборудование для подготовки книги и проверки программ.

И главное — я хочу поблагодарить мою жену Мэри, еще раз смирившуюся с долгими ча-

сами, которые я провел, работая над этой книгой (несмотря на клятвы вроде “больше нико-

гда” после завершения книги о языке SR).

Грег Эндрюс

Таксон, Аризона

Глава 1

Обзор области параллельных

вычислений

Представьте себе такую картину: несколько автомобилей едут из пункта А в пункт В. Ма-

шины могут бороться за дорожное пространство и либо следуют в колонне, либо обгоняют

друг друга (попадая при этом в аварии!). Они могут также ехать по параллельным полосам до-

роги и прибыть почти одновременно, не “переезжая” дорогу друг другу. Возможен вариант,

когда все машины поедут разными маршрутами и по разным дорогам.

Эта картина демонстрирует суть параллельных вычислений: есть несколько задач, которые

должны быть выполнены (едущие машины). Можно выполнять их по одной на одном процес-

соре (дороге), параллельно на нескольких процессорах (дорожных полосах) или на распреде-

ленных процессорах (отдельных дорогах). Однако задачам нужно синхронизироваться, чтобы

избежать столкновений или задержки на знаках остановки и светофорах.

Данная книга — это “атлас” параллельных вычислений. В ней рассматриваются типы ав-

томашин (процессов), возможные пути их следования (приложения), схемы дорог

(аппаратного обеспечения) и правила дорожного движения (взаимодействие и синхрониза-

ция). Так что заправьте полный бак и приготовьтесь к старту.

В данной главе рассказывается о надписях на карте параллельного программирования.

В разделе 1.1 представлены основные понятия. В разделах 1.2 и 1.3 описаны виды аппаратной

части и приложения, которые делают параллельное программирование интересным и перспек-

тивным. В разделах с 1.4 по 1.8 описываются и иллюстрируются пять стилей программирования

циклических вычислений: итеративный параллелизм, рекурсивный параллелизм,

“производители и потребители”, “клиенты и серверы” и, наконец, взаимодействующие каналы.

В последнем разделе определена нотация программ, используемая в дальнейшем.

В следующих главах подробно рассмотрены приложения и методы программирования.

Книга состоит из трех частей, в которых описано программирование с разделяемыми перемен-

ными, распределенное (основанное на сообщениях) и синхронное параллельное. Введение

в каждую часть и главу служит картой маршрута, подводя итоги пройденного и предстоящего пути.

1.1. Суть параллельного программирования

Параллельная программа содержит несколько процессов, работающих совместно над вы-

полнением некоторой задачи. Каждый процесс — это последовательная программа,

а точнее — последовательность операторов, выполняемых один за другим. Последовательная

программа имеет один поток управления, а параллельная — несколько.

Совместная работа процессов параллельной программы осуществляется с помощью их

взаимодействия. Взаимодействие программируется с применением разделяемых переменных

или пересылки сообщений. Если используются разделяемые переменные, то один процесс

осуществляет запись в переменную, считываемую другим процессом. При пересылке сооб-

щений один процесс отправляет сообщение, которое получает другой.

При любом виде взаимодействия процессам необходима взаимная синхронизация. Суще-

ствуют два основных вида синхронизации — взаимное исключение и условная синхрониза-

20

Глава 1. Обзор области параллельных вычислений

ция. Взаимное исключение обеспечивает, чтобы критические секции операторов не выполня-

лись одновременно. Условная синхронизация задерживает процесс до тех пор, пока не выпол-

нится определенное условие. Например, взаимодействие процессов производителя и потреби-

теля часто обеспечивается с помощью буфера в разделяемой памяти. Производитель записывает

в буфер, потребитель читает из него. Чтобы предотвратить одновременное использование буфе-

ра и производителем, и потребителем (тогда может быть считано не полностью записанное со-

общение), используется взаимное исключение. Условная синхронизация используется для про-

верки, было ли считано потребителем последнее записанное в буфер сообщение.

Как и другие прикладные области компьютерных наук, параллельное программирование

прошло несколько стадий. Оно возникло благодаря новым возможностям, предоставленным

развитием аппаратного обеспечения, и развилось в соответствии с технологическими изме-

нениями. Через некоторое время специализированные методы были объединены в набор ос-

новных принципов и общих методов программирования.

Параллельное программирование возникло в 1960-е годы в сфере операционных систем.

Причиной стало изобретение аппаратных модулей, названных каналами, или контроллерами

устройств. Они работают независимо от управляющего процессора и позволяют выполнять

операции ввода-вывода параллельно с инструкциями центрального процессора. Канал взаи-

модействует с процессором с помощью прерывания — аппаратного сигнала, который говорит:

“Останови свою работу и начни выполнять другую последовательность инструкций”.

Результатом появления каналов стала проблема программирования (настоящая интеллек-

туальная проблема) — теперь части программы могли быть выполнены в непредсказуемом

порядке. Следовательно, пока одна часть программы обновляет значение некоторой пере-

менной, может возникнуть прерывание, приводящее к выполнению другой части программы,

которая тоже попытается изменить значение этой переменной. Эта специфическая проблема

(задача критической секции) подробно рассматривается в главе 3.

Вскоре после изобретения каналов началась разработка многопроцессорных машин, хотя

в течение двух десятилетий они были слишком дороги для широкого использования. Однако

сейчас все крупные машины являются многопроцессорными, а самые большие имеют сотни

процессоров и часто называются машинами с массовым параллелизмом (massively parallel proc-

essors). Скоро даже персональные компьютеры будут иметь несколько процессоров.

Многопроцессорные машины позволяют разным прикладным программам выполнять-

ся одновременно на разных процессорах. Они также ускоряют выполнение приложения,

если оно написано (или переписано) для многопроцессорной машины. Но как синхрони-

зировать работу параллельных процессов? Как использовать многопроцессорные системы

для ускорения выполнения программ?

Итак, при использовании каналов и многопроцессорных систем возникают и возможно-

сти, и трудности. При написании параллельной программы необходимо решать, сколько

процессов и какого типа нужно использовать, и как они должны взаимодействовать. Эти ре-

шения зависят как от конкретного приложения, так и от аппаратного обеспечения, на кото-

ром будет выполняться программа. В любом случае ключом к созданию корректной про-

граммы является правильная синхронизация взаимодействия процессов.

Эта книга охватывает все области параллельного программирования, но основное внимание

уделяет императивным программам с явными параллельностью, взаимодействием и синхрониза-

цией. Программист должен специфицировать действия всех процессов, а также их взаимодейст-

вие и синхронизацию. Это контрастирует с декларативными программами, например, функцио-

нальными или логическими, где параллелизм скрыт и отсутствуют чтение и запись состояния

программы. В декларативных программах независимые части программы могут выполняться

параллельно; их взаимодействие и синхронизация происходят неявно, когда одна часть про-

граммы зависит от результата выполнения другой. Декларативный подход тоже интересен и ва-

жен (см. главу 12), но императивный распространен гораздо шире. Кроме того, для реализации

декларативной программы на стандартной машине необходимо писать императивную программу.

1.2. Структуры аппаратного обеспечения

21

Изучаются также параллельные программы, в которых процессы выполняются асинхронно, т.е.

каждый со своей скоростью. Такие программы могут выполняться с помощью чередования про-

цессов на одном процессоре или их параллельного выполнения на мультипроцессоре со многими

командами и многими данными (MIMD-процессоре). К этому классу машин относятся также

мультипроцессоры с разделяемой памятью, многомашинные системы с распределенной памятью

и сети рабочих станций (см. следующий раздел). Несмотря на внимание к асинхронным парал-

лельным вычислениям, в главе 3 мы описываем синхронную мультиобработку (SIMD-машины),

а в главах 3 и 12 — связанный с ней стиль программирования, параллельного поданным.

1.2. Структуры аппаратного обеспечения

В данной главе дается обзор основных атрибутов архитектуры современных компьютеров.

В следующем разделе описаны приложения параллельного программирования и использова-

ние архитектуры в них. Описание начинается с однопроцессорных систем и кэш-памяти. За-

тем рассматриваются мультипроцессоры с разделяемой памятью. В конце описываются ма-

шины с распределенной памятью, к которым относятся многомашинные системы с распре-

деленной памятью и сети машин.

1.2.1. Процессоры и кэш-память

Современная однопроцессорная машина состоит из нескольких компонентов: централь-

ного процессорного устройства (ЦПУ), первичной памяти, одного или нескольких уровней

кэш-памяти (кэш), вторичной (дисковой) памяти и набора периферийных устройств

(дисплей, клавиатура, мышь, модем, CD, принтер и т.д.). Основными компонентами для выпол-

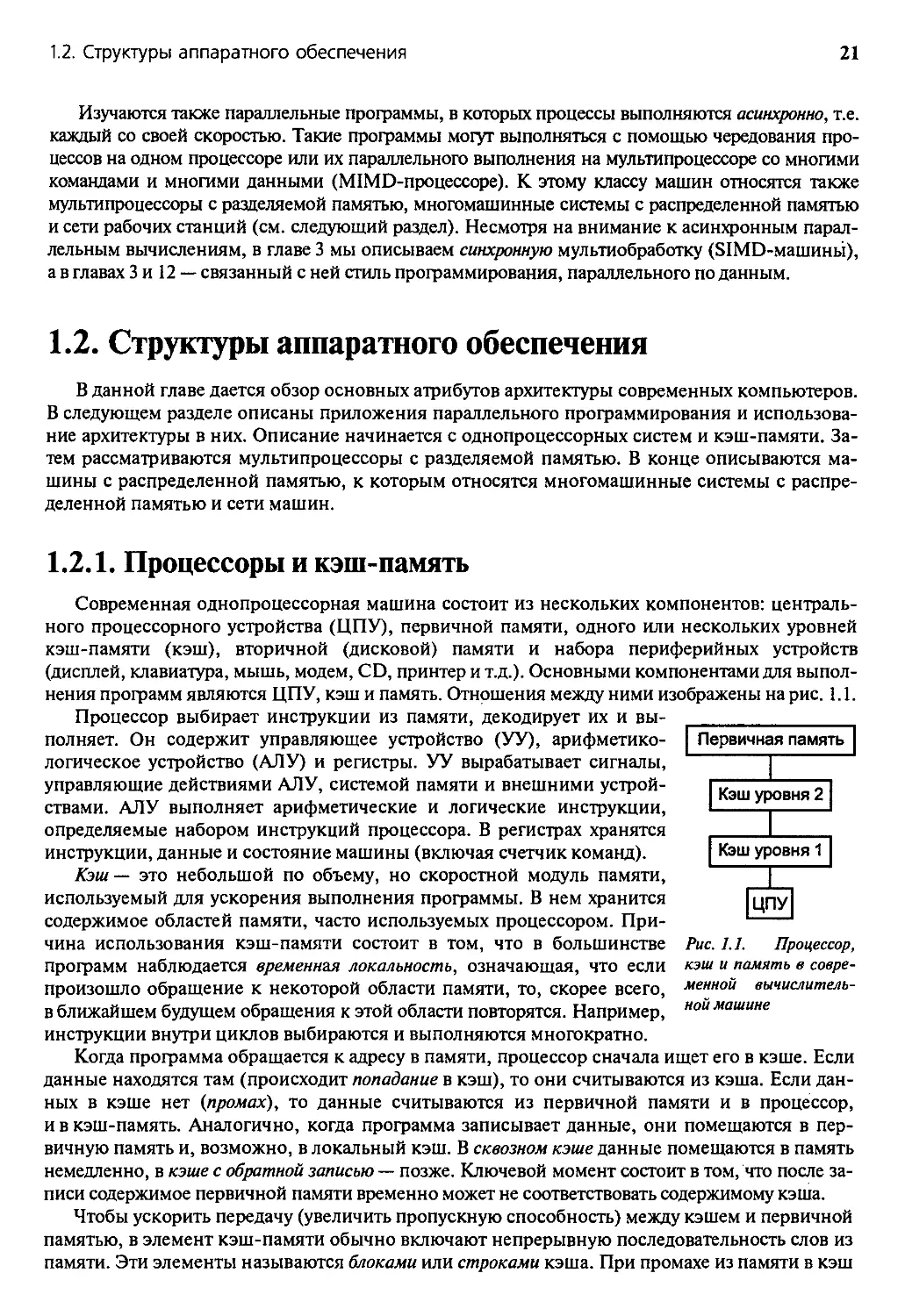

нения программ являются ЦПУ, кэш и память. Отношения между ними изображены на рис. 1.1.

Процессор выбирает инструкции из памяти, декодирует их и вы-

полняет. Он содержит управляющее устройство (УУ), арифметико-

логическое устройство (АЛУ) и регистры. УУ вырабатывает сигналы,

управляющие действиями АЛУ, системой памяти и внешними устрой-

ствами. АЛУ выполняет арифметические и логические инструкции,

определяемые набором инструкций процессора. В регистрах хранятся

инструкции, данные и состояние машины (включая счетчик команд).

Кэш — это небольшой по объему, но скоростной модуль памяти,

используемый для ускорения выполнения программы. В нем хранится

содержимое областей памяти, часто используемых процессором. При-

чина использования кэш-памяти состоит в том, что в большинстве

программ наблюдается временная локальность, означающая, что если

произошло обращение к некоторой области памяти, то, скорее всего,

в ближайшем будущем обращения к этой области повторятся. Например,

инструкции внутри циклов выбираются и выполняются многократно.

Рис. 1.1. Процессор,

кэш и память в совре-

менной вычислитель-

ной машине

Когда программа обращается к адресу в памяти, процессор сначала ищет его в кэше. Если

данные находятся там (происходит попадание в кэш), то они считываются из кэша. Если дан-

ных в кэше нет (промах), то данные считываются из первичной памяти и в процессор,

и в кэш-память. Аналогично, когда программа записывает данные, они помещаются в пер-

вичную память и, возможно, в локальный кэш. В сквозном кэше данные помещаются в память

немедленно, в кэше с обратной записью — позже. Ключевой момент состоит в том, что после за-

писи содержимое первичной памяти временно может не соответствовать содержимому кэша.

Чтобы ускорить передачу (увеличить пропускную способность) между кэшем и первичной

памятью, в элемент кэш-памяти обычно включают непрерывную последовательность слов из

памяти. Эти элементы называются блоками или строками кэша. При промахе из памяти в кэш

22

Глава 1. Обзор области параллельных вычислений

передается полная строка. Это эффективно, поскольку в большинстве программ наблюдается

пространственная локальность, т.е. за обращением к одному слову памяти вскоре последуют

обращения к другим близлежащим словам.

В современных процессорах обычно есть два типа кэша. Кэш уровня 1 находится ближе

к процессору, а кэш уровня 2 — между кэшем уровня 1 и первичной памятью. Кэш уров-

ня 1 меньше и быстрее, чем кэш уровня 2, и зачастую иначе организован. Например, кэш-

память уровня 1 обычно отображается непосредственно, а кэш уровня 2 является множест-

венно-ассоциативным.2 Кроме того, кэш уровня 1 часто содержит отдельные области кэш-

памяти для инструкций и данных, в то время как кэш уровня 2 обычно унифицирован, т.е.

в нем хранятся и данные, и инструкции.

Проиллюстрируем различия в скорости работы уровней иерархии памяти. Доступ к реги-

страм происходит за один такт работы процессора, поскольку они невелики и находятся

внутри ЦПУ. Данные кэш-памяти уровня 1 также доступны за один-два такта. Однако для

доступа к кэш-памяти уровня 2 необходимо порядка 10 тактов, а к первичной памяти — от 50

до 100 тактов. Аналогичны и различия в размере типов памяти: ЦПУ содержит несколько де-

сятков регистров, кэш уровня 1 — несколько десятков килобайт, кэш уровня 2 — порядка

мегабайта, а первичная память — десятки и сотни мегабайт.

1.2.2. Мультипроцессоры с разделяемой памятью

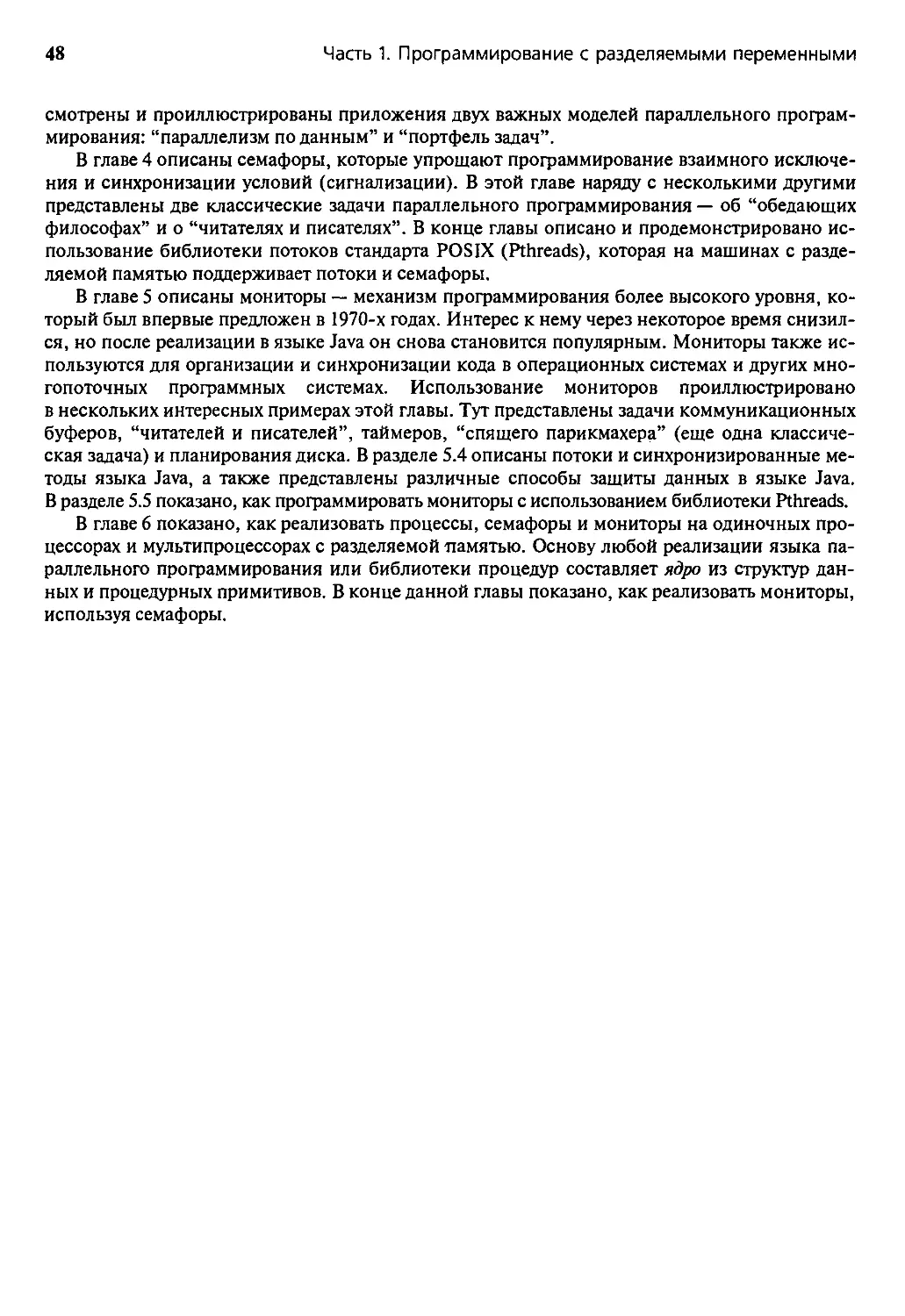

В мультипроцессоре с разделяемой памятью процессоры и модули памяти связаны с помо-

щью соединительной сети (рис. 1.2). Процессоры совместно используют первичную память,

но каждый из них имеет собственный кэш.

Рис. 1.2. Структура мультипроцессоров с разде-

ляемой памятью

В небольшом мультипроцессоре, имеющем от двух до (порядка) 30 процессоров, соедини-

тельная сеть реализована в виде шины памяти или, возможно, матричного коммутатора. Та-

кой мультипроцессор называется однородным (UMA machine — от “uniform memory access”),

поскольку время доступа каждого из процессоров к любому участку памяти одинаково. Од-

нородные машины также называются симметричными мультипроцессорами.

В больших мультипроцессорах с разделяемой памятью, включающих десятки или сотни

процессоров, память организована иерархически. Соединительная сеть имеет вид древооб-

разного набора переключателей и областей памяти. Следовательно, одна часть памяти

ближе к определенному процессору, другая — дальше от него. Такая организация памяти

2 В непосредственно отображаемом кэше каждый адрес памяти отображается в один элемент кэша,

а в множественно-ассоциативном — во множество элементов (обычно два или четыре). Таким образом,

если два адреса памяти отображаются в одну и ту же ячейку, в непосредственно отображаемом кэше мо-

жет находиться только ячейка, к которой производилось самое последнее обращение, а в ассоциатив-

ном — обе ячейки. С другой стороны, непосредственно отображаемый кэш быстрее, поскольку проще

выяснить, есть ли данное слово в кэше.

1.2. Структуры аппаратного обеспечения

23

позволяет избежать перегрузки, возникающей при использовании одной шины или комму-

татора, и приводит к неравным временам доступа, поэтому такие мультипроцессоры назы-

ваются неоднородными (NUMA machines).

В машинах обоих типов у каждого процессора есть собственный кэш. Если два процессора

ссылаются на разные области памяти, их содержимое можно безопасно поместить в кэш каж-

дого из них. Проблема возникает, когда два процессора обращаются к одной области памяти

примерно одновременно. Если оба процессора только считывают данные, в кэш каждого из

них можно поместить копию данных. Но если один из процессоров записывает в память, воз-

никает проблема согласованности кэша: в кэш-памяти другого процессора теперь содержатся не-

верные данные. Значит, необходимо либо обновить кэш другого процессора, либо признать со-

держимое кэша недействительным. В каждом мультипроцессоре протокол согласования кэш-

памяти должен быть реализован аппаратно. Один из способов состоит в том, чтобы каждый кэш

“следил” за адресной шиной, отлавливая ссылки на области памяти, находящиеся в нем.

Запись в память также приводит к проблеме согласованности памяти: когда в действи-

тельности обновляется первичная память? Например, если один процессор выполняет запись

в область памяти, а другой позже считывает данные из этой области, будет ли считано обнов-

ленное значение? Существует несколько различных моделей согласованности памяти. После-

довательная согласованность — это наиболее сильная модель. Она гарантирует, что обновле-

ния памяти будут происходить в некоторой последовательности, причем каждому процессору

будет “видна” одна и та же последовательность. Согласованность процессоров — более слабая

модель. Она обеспечивает, что записи в память, выполняемые каждым процессом, соверша-

ются в том порядке, в котором их производит процессор, но записи, инициированные раз-

личными процессорами, для других процессоров могут выглядеть по-разному. Еще более

слабая модель— согласование освобождения, при которой первичная память обновляется

в указанных программистом точках синхронизации.

Проблема согласования памяти представляет противоречия между простотой программиро-

вания и расходами на реализацию. Программист интуитивно ожидает последовательного согла-

сования, поскольку программа считывает и записывает переменные независимо от того, в какой

части машины они хранятся в действительности. Когда процесс присваивает переменной значе-

ние, программист ожидает, что результаты этого присваивания станут немедленно известными

всем процессам программы. С другой стороны, последовательное согласование очень дорого

в реализации и замедляет работу машины. Дело в том, что при каждой записи аппаратная часть

должна проверить все кэши (и, возможно, обновить их или сделать недействительными) и мо-

дифицировать первичную память. Вдобавок, эти действия должны быть неделимыми. Вот почему

в мультипроцессорах обычно реализуется более слабая модель согласования памяти, а програм-

мистам необходимо вставлять инструкции синхронизации памяти. Это часто обеспечивают

компиляторы и библиотеки, так что прикладной программист этим может не заниматься.

Как было отмечено, строки кэш-памяти часто содержат последовательности слов, кото-

рые блоками передаются из памяти и обратно. Предположим, что переменные х и у занимают

по одному слову и хранятся в соседних ячейках памяти, отображенных в одну и ту же строку

кэш-памяти. Пусть некоторый процесс выполняется на процессоре 1 мультипроцессора

и производит записи и чтения переменной х. Наконец, допустим, что еще один процесс, вы-

полняемый на процессоре 2, считывает и записывает переменную у. Тогда при каждом обра-

щении процессора 1 к переменной х строка кэш-памяти этого процессора будет содержать

и копию переменной у. Аналогичная картина будет и в кэше процессора 2.

Ситуация, описанная выше, называется ложным разделением: процессы в действительности

не разделяют переменные х и у, но аппаратная часть кэш-памяти интерпретирует обе перемен-

ные как один блок. Следовательно, когда процессор 1 обновляет переменную х, должна быть

признана недействительной и обновиться строка кэша в процессоре 2, содержащая и х, и у. Та-

ким же образом, когда процессор 2 обновляет значение у, строка кэш-памяти, содержащая зна-

чения х и у, в процессоре 1 тоже должна быть обновлена или признана недействительной. Эти

операции замедляют работу системы памяти, поэтому программа будет выполняться намного

24

Глава 1. Обзор области параллельных вычислений

медленнее, чем тогда, когда две переменные попадают в разные строки кэша. Главное здесь —

чтобы программист ясно понимал, что процессы не разделяют переменные, когда фактически

система памяти вынуждена обеспечивать их разделение и тратить время на управление им.

Чтобы избежать ложного разделения, программист должен гарантировать, что перемен-

ные, записываемые различными процессами, не будут находиться в смежных областях памя-

ти. Одно из решений этой проблемы заключается в выравнивании, т.е. резервировании фик-

тивных переменных, которые просто занимают место и отделяют реальные переменные друг

от друга. Это пример противоречия между временем и пространством: для сокращения вре-

мени выполнения приходится тратить пространство.

Итак, мультипроцессоры используют кэш-память для повышения производительности.

Однако иерархичность памяти порождает проблемы согласованности кэша и памяти, а также

возможность ложного разделения. Следовательно, для получения максимальной производи-

тельности на данной машине программист должен знать характеристики системы памяти

и писать программы, учитывая их. К этим вопросам мы еще вернемся.

1.2.3. Мультикомпьютеры с распределенной памятью и сети

В мультипроцессоре с распределенной памятью тоже есть соединительная сеть, но каждый

процессор имеет собственную память. Как показано на рис. 1.3, соединительная сеть и моду-

ли памяти меняются местами по сравнению с их положением в мультипроцессоре с разде-

ляемой памятью. Соединительная сеть поддерживает передачу сообщений, а не чтение и запись

в память. Следовательно, процессоры взаимодействуют, передавая и принимая сообщения.

У каждого процессора есть свой кэш, но из-за отсутствия разделения памяти нет проблем

согласованности кэша и памяти.

Мультикомпьютер (многомашинная система) — это мультипроцессор с распределенной

памятью, в котором процессоры и сеть расположены физически близко (в одном помеще-

нии). По этой причине такую многомашинную систему часто называют тесно связанной

(спаренной) машиной. Она одновременно используется одним или небольшим количеством

приложений; каждое приложение задействует выделенный набор процессоров. Соедини-

тельная сеть с большой пропускной способностью предоставляет высокоскоростной путь свя-

зи между процессорами. Обычно она организована в гиперкуб или матричную структуру.

(Машины со структурой типа гиперкуб были одними из первых многомашинных систем.)

Сетевая система — это многомашинная система с распределенной памятью, узлы которой

связаны с помощью локальной сети типа Ethernet или такой глобальной сети, как Internet.

Сетевые системы называются слабо связанными мультикомпьютерами. Здесь процессоры

взаимодействуют также с помощью передачи сообщений, но время их доставки больше, чем

в многомашинных системах, и в сети больше конфликтов. С другой стороны, сетевая система

строится на основе обычных рабочих станций и сетей, тогда как в многомашинной системе

часто есть специализированные компоненты, особенно у связующей сети.

1.3. Приложения и стили программирования

25

Сетевая система, состоящая из набора рабочих станций, часто называется сетью рабочих

станций (network of workstations — NOW) или кластером рабочих станций (cluster of worksta-

tions — COW). Все рабочие станции выполняют одно или несколько приложений, возможно,

связанных между собой. Популярный сейчас способ построения недорогого мультипроцес-

сора с распределенной памятью — собрать так называемую машину Беовулфа (Beowulf). Она

состоит из базового аппаратного обеспечения и таких бесплатных программ, как чипы к про-

цессорам Pentium, сетевые карты, диски и операционная система Linux. (Имя Беовулф взято

из старинной английской поэмы, первого шедевра английской литературы.)

Существуют также гибридные сочетания мультипроцессоров с распределенной и разде-

ляемой памятью. Узлами системы с распределенной памятью могут быть мультипроцессоры

с разделяемой памятью, а не обычные процессоры. Возможен вариант, когда связующая сеть

поддерживает и механизмы передачи сообщений, и механизмы прямого доступа к удаленной

памяти (на сегодня это наиболее мощные машины). Наиболее общая комбинация — машина

с поддержкой распределенной разделяемой памяти, т.е. распределенной реализации абстрак-

ции разделяемой памяти. Она облегчает программирование многих приложений, но ставит

проблемы согласованности кэша и памяти. (В главе 10 описана распределенная разделяемая

память и ее реализация в программном обеспечении.)

1.3. Приложения и стили программирования

Параллельное программирование обеспечивает способ организации программного обес-

печения, состоящего из относительно независимых частей. Оно также позволяет использо-

вать множественные процессоры. Существует три обширных перекрывающихся класса при-

ложений — многопоточные системы, распределенные системы и синхронные параллельные

вычисления — и три соответствующих им типа параллельных программ.

Напомним, что процесс— это последовательная программа, которая при выполнении

имеет собственный поток управления. Каждая параллельная программа содержит несколько

процессов, поэтому имеет несколько потоков. Однако термин многопоточный обычно означа-

ет, что программа содержит больше процессов (потоков), чем существует процессоров для их

выполнения. Следовательно, процессы на процессорах выполняются по очереди. Многопо-

точная программная система управляет множеством независимых процессов, например таких:

• оконные системы на персональных компьютерах или рабочих станциях;

• многопроцессорные операционные системы и системы с разделением времени;

• системы реального времени, управляющие электростанциями, космическими аппара-

тами и т.д.

Эти системы разработаны как многопоточные программы, поскольку организовать код

и структуры данных в виде набора процессов намного проще, чем реализовать огромную по-

следовательную программу. Кроме того, каждый процесс может планироваться и выполнять-

ся независимо. Например, когда пользователь нажимает кнопку мыши персонального ком-

пьютера, посылается сигнал процессу, управляющему окном, в котором в данный момент на-

ходится курсор мыши. Этот процесс (поток) может выполняться и отвечать на щелчок мыши.

Приложения в других окнах могут продолжать при этом свое выполнение в фоновом режиме.

Второй широкий класс приложений образуют распределенные вычисления, в которых ком-

поненты выполняются на машинах, связанных локальной или глобальной сетью. По этой

причине процессы взаимодействуют, обмениваясь сообщениями. Вот примеры:

• файловые серверы в сети;

• системы баз данных для банков, заказа авиабилетов и т.д.;

• Web-серверы сети Internet;

26 Глава 1. Обзор области параллельных вычислений

• предпринимательские системы, объединяющие компоненты производства;

• отказоустойчивые системы, которые продолжают работать независимо от сбоев

в компонентах.

Такие системы пишутся для распределения обработки (как в файловых серверах), обеспече-

ния доступа к удаленным данным (как в базах данных и в Web), интеграции и управления

данными, распределенными по своей сути (как в промышленных системах), или повышения

надежности (как в отказоустойчивых системах). Многие распределенные системы организо-

ваны как системы типа клиент-сервер. Например, файловый сервер предоставляет файлы

данных для процессов, выполняемых на клиентских машинах. Компоненты распределенных

систем часто сами являются многопоточными программами.

Синхронные параллельные вычисления — третий широкий класс приложений. Их цель —

быстро решить данную задачу или за то же время решить большую задачу. Примеры синхрон-

ных вычислений:

• научные вычисления, которые моделируют и имитируют такие явления, как глобальный

климат, эволюция солнечной системы или результат действия нового лекарства;

• графика и обработка изображений, включая создание спецэффектов в кино;

• крупные комбинаторные или оптимизационные задачи, например, планирование

авиаперелетов или экономическое моделирование.

Программы решения таких задач требуют больших вычислительных мощностей. Для дости-

жения высокой производительности они выполняются на параллельных процессорах, причем

обычно количество процессов (потоков) равно числу процессоров. Параллельные вычисле-

ния описываются в виде программ, параллельных по данным, в которых все процессы выпол-

няют одни и те же действия, но с собственной частью данных, или в виде программ, параллель-

ных по задачам, в которых различные процессы решают различные задачи.

В данной книге рассмотрены все три вида приложений и, что более важно, показано, как

их программировать. В многопоточных программах процессы (потоки) взаимодействуют, ис-

пользуя разделяемые переменные. В распределенных системах взаимодействие процессов

обеспечивается с помощью обмена сообщениями или удаленного вызова операций. При вы-

полнении синхронных параллельных вычислений процессы взаимодействуют, используя или

разделяемые переменные, или передачу сообщений, в зависимости от аппаратного обеспече-

ния, на котором выполняется программа. В части 1 этой книги показано, как написать про-

грамму, использующую для взаимодействия и синхронизации разделяемые переменные.

Часть 2 описывает передачу сообщений и удаленные операции. В части 3 подробно рассмотрено

синхронное параллельное программирование, ориентированное на научные вычисления.

Существует немало параллельных программных приложений, однако в них используется

лишь небольшое число моделей решений, или парадигм. В частности, существует пять основ-

ных парадигм: 1) итеративный параллелизм, 2) рекурсивный параллелизм, 3) “производители

и потребители” (конвейеры), 4) “клиенты и серверы”, 5) взаимодействующие равные. С ис-

пользованием одной или нескольких из этих парадигм и программируются приложения.

Итеративный параллелизм используется, когда в программе есть несколько процессов

(часто идентичных), каждый из которых содержит один или несколько циклов. Таким обра-

зом, каждый процесс является итеративной программой. Процессы программы работают со-

вместно над решением одной задачи; они взаимодействуют и синхронизируются с помощью

разделяемых переменных или передачи сообщений. Итеративный параллелизм чаще всего

встречается в научных вычислениях, выполняемых на нескольких процессорах.

Рекурсивный параллелизм может использоваться, когда в программе есть одна или несколь-

ко рекурсивных процедур, и их вызовы независимы, т.е. каждый из них работает над своей

частью общих данных. Рекурсия часто применяется в императивных языках программирова-

ния, особенно при реализации алгоритмов типа “разделяй и властвуй” или “перебор с воз-

1.4. Итеративный параллелизм: умножение матриц

27

вращением” (backtracking). Рекурсия является одной из фундаментальных парадигм и в сим-

волических, логических, функциональных языках программирования. Рекурсивный паралле-

лизм используется для решения таких комбинаторных проблем, как сортировка, планирова-

ние (задача коммивояжера) и игры (шахматы и другие).

Производители и потребители — это взаимодействующие процессы. Они часто организуются

в конвейер, через который проходит информация. Каждый процесс конвейера является фильт-

ром, который потребляет выход своего предшественника и производит входные данные для сво-

его последователя. Фильтры встречаются на уровне приложений (оболочки) в операционных

системах типа ОС Unix, внутри самих операционных систем, внутри прикладных программ, ес-

ли один процесс производит выходные данные, которые потребляет (читает) другой процесс.

Клиенты и серверы — наиболее распространенная модель взаимодействия в распределен-

ных системах, от локальных сетей до World Wide Web. Клиентский процесс запрашивает сер-

вис и ждет ответа. Сервер ожидает запросов от клиентов, а затем действует в соответствии

с этими запросами. Сервер может быть реализован как одиночный процесс, который не мо-

жет обрабатывать одновременно несколько клиентских запросов, или (при необходимости

параллельного обслуживания запросов) как многопоточная программа. Клиенты и серверы

представляют собой параллельное программное обобщение процедур и их вызовов: сервер

выполняет роль процедуры, а клиенты ее вызывают. Но если код клиента и код сервера рас-

положены на разных машинах, обычный вызов процедуры использовать нельзя. Вместо этого

необходимо использовать удаленный вызов процедуры или рандеву, как это описано в главе 8.

Взаимодействующие равные — последняя парадигма взаимодействия. Она встречается

в распределенных программах, в которых несколько процессов для решения задачи выпол-

няют один и тот же код и обмениваются сообщениями. Взаимодействующие равные исполь-

зуются для реализации распределенных параллельных программ, особенно при итеративном

параллелизме и децентрализованном принятии решений в распределенных системах. Неко-

торые приложения и схемы взаимодействия описаны в главе 9.

В следующих пяти разделах приводятся примеры, иллюстрирующие применение каж-

дой модели. В примерах представлена программная нотация, используемая во всей книге.

(Обзор нотации дается в разделе 1.9.) Еще больше примеров приведено в тексте и упраж-

нениях последующих глав.

1.4. Итеративный параллелизм: умножение матриц

Итеративная последовательная программа использует для обработки данных и вычисле-

ния результатов циклы типа for и while. Итеративная параллельная программа содержит

несколько итеративных процессов. Каждый процесс вычисляет результаты для подмножества

данных, а затем эти результаты собираются вместе.

В качестве простого примера рассмотрим задачу из области научных вычислений. Предпо-

ложим, даны матрицы а и Ь, у каждой по п строк и столбцов, и обе инициализированы. Цель —

вычислить произведение матриц, поместив результат в матрицу с размером пхп. Для этого

нужно вычислиты12 промежуточных произведений, по одному для каждой пары строк и столбцов.

Матрицы являются разделяемыми переменными, объявленными следующим образом,

double а[п,п], Ь[п,п], с[п,п];

При условии, что п уже объявлено и инициализировано, это объявление резервирует память

для трех массивов действительных чисел двойной точности. По умолчанию индексы строк

и столбцов изменяются от 0 до п-1.

После инициализации массивов а и Ь можно вычислить произведение матриц по такой

последовательной программе.

for [i = 0 to n-1] {

for [j = 0 to n-1] {

28

Глава 1. Обзор области параллельных вычислений

# вычислить произведение a[i,*] и b[*,j]

c[i,j] = 0.0;

for [к = 0 to n-1]

c[i,j] = c[i,j] + a[i,k]*b[k,j];

}

}

Внешние циклы (с индексами i и j) повторяются для каждой строки и столбца. Во внутрен-

нем цикле (с индексом к) вычисляется промежуточное произведение строки i матрицы а

и столбца j матрицы Ь; результат сохраняется в ячейке с [ i, j ]. Строка с символом # в нача-

ле является комментарием.

Умножение матриц — это пример приложения с массовым параллелизмом, поскольку про-

грамма содержит большое число операций, которые могут выполняться параллельно. Две опе-

рации могут выполняться параллельно, если они независимы. Предположим, что множество

чтения операции содержит переменные, которые она читает, но не изменяет, а множество запи-

си — переменные, которые она изменяет (и, возможно, читает). Две операции являются незави-

симыми, если их множества записи не пересекаются. Говоря неформально, процессы всегда

могут безопасно читать переменные, которые не изменяются. Однако двум процессам в общем

случае небезопасно выполнять запись в одну и ту же переменную или одному процессу читать

переменную, которая записывается другим. (Эта тема рассматривается подробно в главе 2.)

При умножении матриц вычисления промежуточных произведений являются независи-

мыми операциями. В частности, строки с 4 по 6 приведенной выше программы выполняют

инициализацию и последующее вычисление элемента матрицы с. Внутренний цикл про-

граммы читает строку матрицы а и столбец матрицы Ь, а затем читает и записывает один эле-

мент матрицы с. Следовательно, множество чтения для внутреннего произведения — это

строка матрицы а и столбец матрицы Ь, а множество записи — элемент матрицы с.

Поскольку множества записи внутренних произведений не пересекаются, их можно вы-

полнять параллельно. Возможны варианты, когда параллельно вычисляются результирующие

строки, результирующие столбцы или группы строк и столбцов. Ниже будет показано, как

запрограммировать такие параллельные вычисления.

Сначала рассмотрим параллельное вычисление строк матрицы с. Его можно запрограм-

мировать с помощью оператора со (от “concurrent” — “параллельный”):

со [i = 0 to п-1] { # параллельное вычисление строк

for [j = 0 to n-1] {

с[i,j] = 0.0;

for [k = 0 to n-1]

c[i,j] = c[i,j] + a[i,k]*b[k,j];

}

}

Между этой программой и ее последовательным вариантом есть лишь одно синтаксическое

различие — во внешнем цикле оператор for заменен оператором со. Но семантическая раз-

ница велика: оператор со определяет, что его тело для каждого значения индекса i будет вы-

полняться параллельно (если не в действительности, то, по крайней мере, теоретически, что

зависит от числа процессоров).

Другой способ выполнения параллельного умножения матриц состоит в параллельном

вычислении столбцов матрицы с. Его можно запрограммировать следующим образом.

со [j = 0 to n-1] { #параллельное вычисление столбцов

for [i = 0 to n-1] {

с [ i,j] = 0.0;

for [k = 0 to n-1]

c[i,j] = c[i,j] + a [ i, k] *b [k, j ] ;

}

)

1.4. Итеративный параллелизм: умножение матриц

29

Здесь два внешних цикла (по i и по j) поменялись местами. Если тела двух циклов незави-

симы и приводят к вычислению одинаковых результатов, их можно безопасно менять мес-

тами, как это было сделано здесь. (Это и другие аналогичные преобразования программ

рассматриваются в главе 12.)

Программу для параллельного вычисления всех промежуточных произведений можно со-

ставить несколькими способами. Используем один оператор со для двух индексов.

со [i = 0 to n-1, j = 0 to п-1] { # все строки и

c[i,j] = 0.0; # все столбцы

for [к = 0 to п-1]

c[i,j] = c[i,j] + а[i,к]*b[k,j] ;

}

}

Тело оператора co выполняется параллельно для каждой комбинации значений индексов i

и j, поэтому программа задает п2 процессов. (Будут ли они выполняться параллельно, зави-

сит от конкретной реализации.) Другой способ параллельного вычисления промежуточных

произведений состоит в использовании вложенных операторов со.

со [i = 0 to п-1] { # строки параллельно, затем

со [j = 0 to п-1] { # столбцы параллельно

c[i,j] = 0.0;

for [k = 0 to n-1]

c[i, j] = c[i,j] + a[i,k]*b[k, j] ;

}

}

Здесь для каждой строки (внешний оператор со) и затем для каждого столбца (внутренний

оператор со) задается по одному процессу. Третий способ написать эту программу — поме-

нять местами две строки последней программы. Результат всех трех программ будет одинако-

вым: выполнение внутреннего цикла для всех п2 комбинаций значений i и j. Разница между

ними — в задании процессов, а значит, и во времени их создания.

Заметим, что все параллельные программы, приведенные выше, были получены заменой

оператора for на со. Но мы сделали это только для индексов i и j. А как быть с внутренним

циклом по индексу к? Нельзя ли и этот оператор заменить оператором со? Ответ — “нет”, по-

скольку тело внутреннего цикла как читает, так и записывает переменную с [ i, j ]. Промежу-

точное произведение — цикл for с переменной к — можно вычислить, используя двоичный па-

раллелизм, но для большинства машйн это непрактично (см. упражнения в конце главы).

Другой способ определить параллельные вычисления, показанные выше, — использовать дек-

ларацию (объявление) process вместо оператора со. В сущности, process — это оператор со,

выполняемый как “фоновый”. Например, первая параллельная программа из показанных выше —

та, что параллельно вычисляет строки результата, — может быть записана следующим образом.

process row[i = 0 to n-1] { # строки параллельно

for [j = 0 to n-1] {

c [ i,j] = 0.0;

for [k = 0 to n-1]

c[i,j] = c[i,j] + a[i,k]*b[k,j];

}

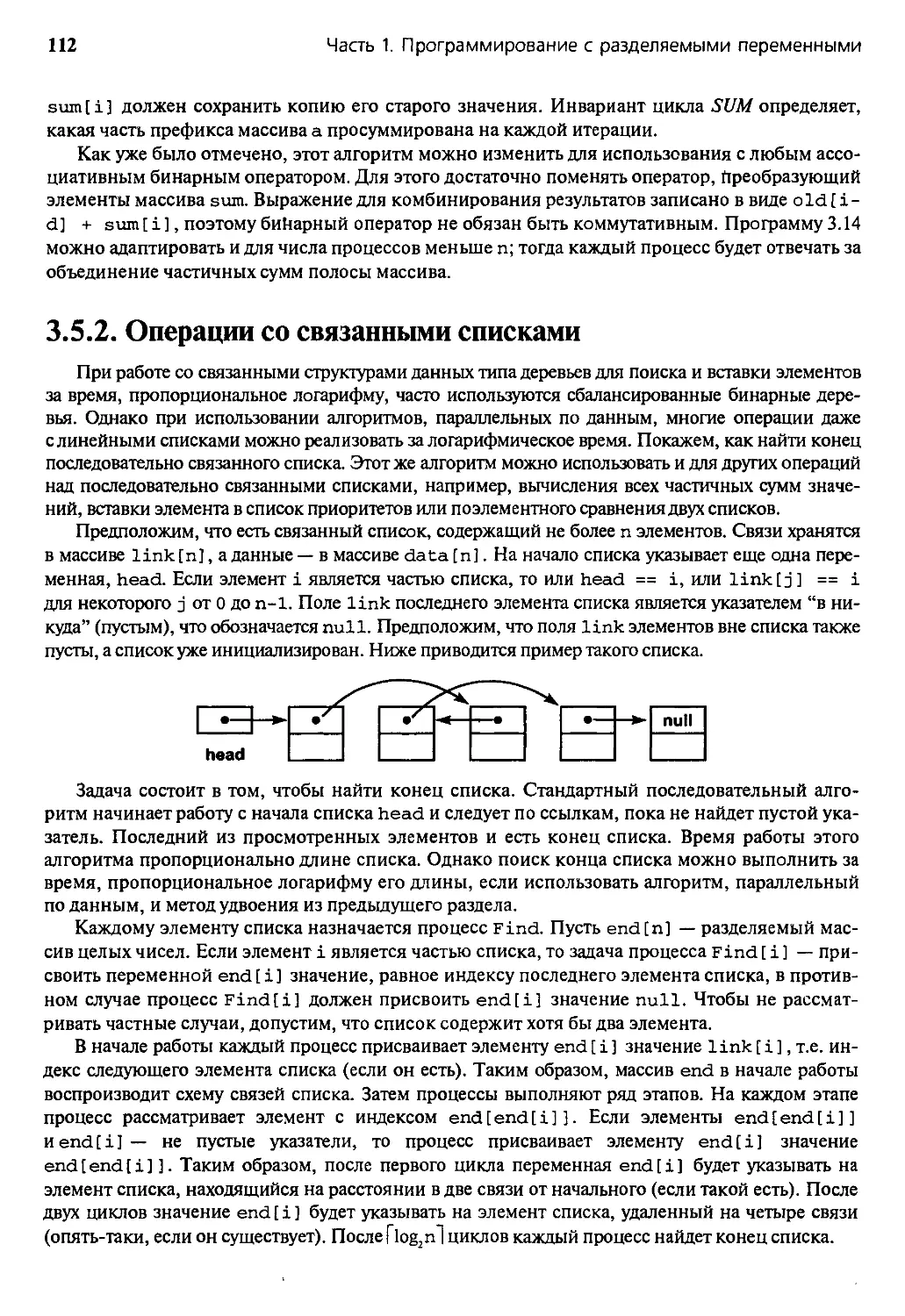

}