Текст

ИЗДАТЕЛЬСТВО

<МИР»

NONLINEAR

AND DYNAMIC PROGRAMMING

BY

G. HADLEY

University of Chicago

and

Universidad de Los Andes

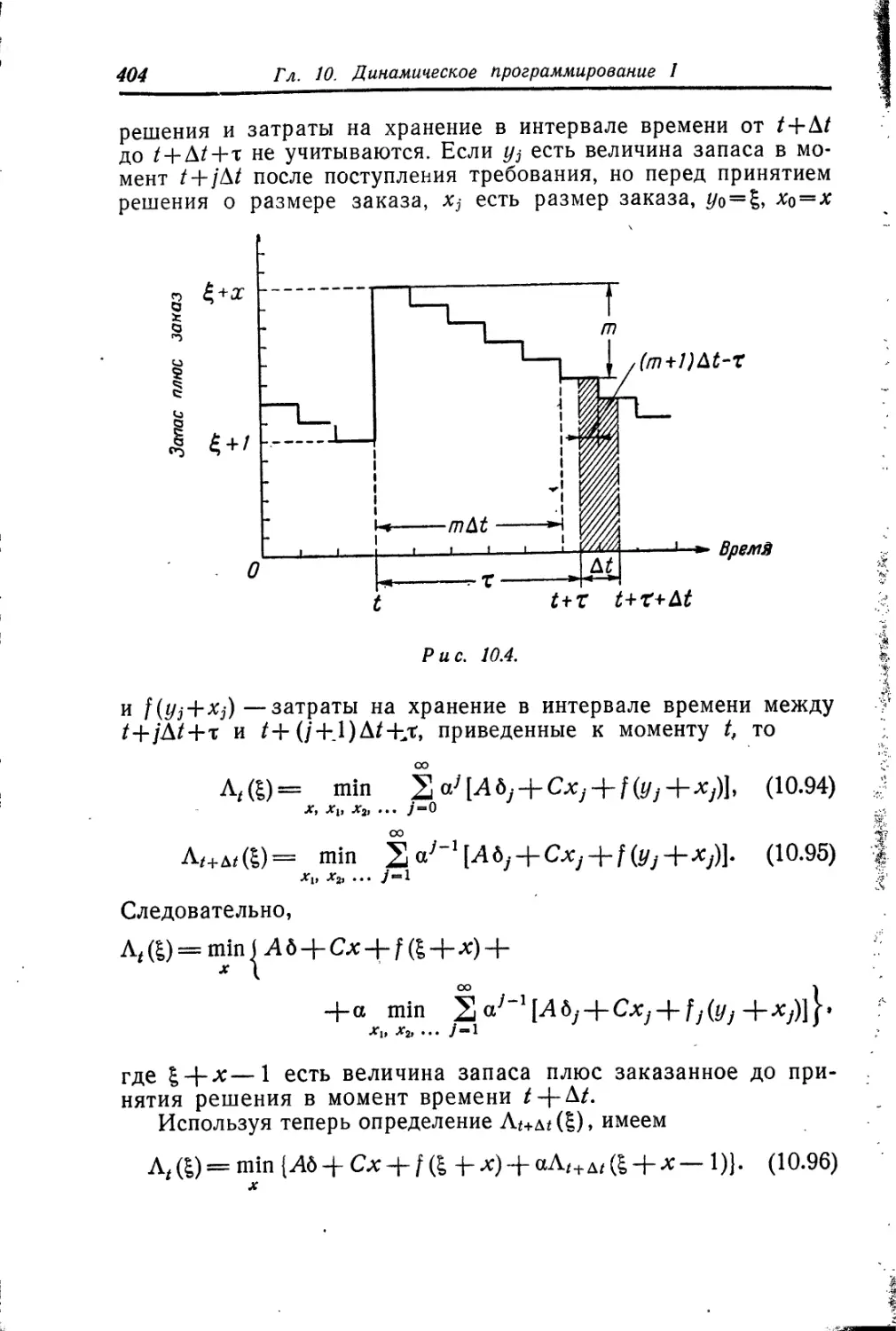

Bogota, Colombia

ADDISON-WESLEY PUBLISHING COMPANY, INC.

READING, MASSACHUSETTS • PALO ALTO • LONDON

1964

Дж. Хедли

НЕЛИНЕЙНОЕ

и

ДИНАМИЧЕСКОЕ

П РО ГРАМ М ИРОВ АНИЕ

Перевод с английского

Ю. И. ВОЛКОВА, А. Б. ГОРСТКО.

А. А. КАПЛАНА. Э. О. РАПОПОРТА

Под редакцией

Г. П. АКИЛОВА

ИЗДАТЕЛЬСТВО ,МИР« МОСКВА 1967

УДК 519.9

Монография содержит подробное исследование теоретических

и вычислительных аспектов нелинейного и динамического про-

граммирования. Автор систематически рассматривает вопросы

практической реализуемости предлагаемых вычислительных мето-

дов. В книге имеется большое количество примеров. Предпола-

гается, что читатель знаком с математическим анализом, линей-

ной алгеброй и линейным программированием, однако для удоб-

ства в книгу включена глава, содержащая необходимый минимум

сведений.

Книга рассчитана на научных работников, инженеров, эконо-

мистов и лиц других специальностей, интересующихся матема-

тическими методами планирования, а также на математиков,

занимающихся приложениями к экономике. Она доступна сту-

дентам и аспирантам соответствующих специальностей.

Редакция литературы по математическим наукам

Ивд. 2-2-3

ОТ РЕДАКТОРА ПЕРЕВОДА

Предлагаемая вниманию читателя книга Дж. Хедли «Нели-

нейное и динамическое программирование» имеет целью позна-

комить неискушенного в математике читателя с задачами, ре-

шение которых сводится к отысканию наибольшего или наи-

меньшего значения некоторой функции, зависящей, как правило,

от большого числа переменных. Такие задачи возникают в

самых разнообразных областях человеческой деятельности

и в первую очередь — это и обусловило повышенный инте-

рес к ним — в практике планирования и организации производ-

ства.

Имея в виду указанный выше круг читателей, автор не стре-

мится углубляться в дебри теоретических исследований. Его

интересует, во-первых, математическое описание различных си-

туаций, типичных для оптимального планирования, и, во-вторых,

численное решение возникающих при этом математических за-

дач. Надо сказать, что эти стороны вопроса совершенно недо-

статочно освещены в советской литературе. Поэтому столь по-

дробное их изложение, которое мы находим в книге Дж. Хедли,

следует расценивать как явление весьма положительное.

Все это дает основания надеяться, что книга окажется

полезной для обширного круга специалистов, так или иначе свя-

занных с оптимальным планированием: от сотрудников научных

учреждений до практических работников предприятий и плано-

вых органов, занимающихся организацией и планированием

производства.

Книга не обращена непосредственно к математикам, но те

из них, кто работает по реализации на ЭВМ задач математиче-

ской экономики или им подобных, также прочтут ее с пользой

для себя.

6 От редактора перевода

При переводе мы сочли нужным сделать некоторые, впрочем

совсем небольшие, сокращения. В ряде случаев оказались не-

обходимыми и другие отступления от текста, главным образом

уточнения отдельных формулировок. Указанные изменения в

оригинале ввиду их незначительности, как правило, не оговари-

ваются.

Список литературы дополнен важнейшими советскими изда-

ниями, имеющими прямое отношение к затронутым в книге во-

просам.

Главы 1, 10, И переведены А. Б. Горстко, главы 2, 8 —

Ю. И. Волковым, главы 3, 4, 6. 7 — А. А. Капланом, главы 5,

9 — Э. О. Рапопортом.

Г. П. Акилов

ПРЕДИСЛОВИЕ

Эта книга задумана как продолжение книги автора «Линей-

ное программирование» и посвящена изучению теоретических и

вычислительных аспектов нелинейного программирования.

Первая глава посвящена обсуждению тех трудностей, ко-

торые возникают при переходе от линейных задач к нелинейным.

Во второй главе делается попытка дать необходимые для

дальнейшего чтения сведения по математике/а также вводятся

принятые обозначения. Благодаря включению этой главы на-

стоящую книгу можно читать независимо от книг автора «Ли-

нейное программирование» и «Линейная алгебра».

Глава 3 содержит описание классических методов оптимиза-

ции, основанных на использовании дифференциального исчисле-

ния. Особенно подробно обсуждается метод множителей Ла-

гранжа. Здесь же определяются основные свойства выпуклых и

вогнутых функций, которые используются в дальнейшем. В этой

главе не делается попытки изучить вариационное исчисление,

так как для этого понадобилось бы слишком много места. О нем

лишь коротко упоминается в главах, посвященных динамиче-

скому программированию.

В гл. 4 изучаются приближенные методы для отыскания ло-

кальных или глобальных экстремумов в задачах нелинейного

программирования.

Пятая глава посвящена задачам стохастического программи-

рования, а шестая — теории Куна—Таккера.

Задачи квадратичного и целочисленного программирования

обсуждаются соответственно в седьмой и восьмой главах.

Глава 9 посвящена градиентным методам решения нелиней-

ных задач, а две последние главы — динамическому программи-

рованию.

Проблемы нелинейного программирования гораздо шире и

разнообразнее, чем проблемы линейного программирования. От-

части это и послужило причиной того, что отдельные главы

иногда содержат описания никак не связанных между собой

методов решения специальных типов задач. Другая причина

состоит в том, что в настоящее время не существует теории»

8

Предисловие

объединяющей все относящееся к нелинейному программирова-

нию, да и вычислительные алгоритмы разработаны лишь для

очень специальных классов задач. Схемы этих алгоритмов

весьма существенно зависят от особенностей решаемых задач.

Для решения рассматриваемых в книге задач было предло-

жено множество вычислительных методов. Так как не предста-

влялось возможным изложить все методы, автор был вынужден

отобрать лишь наиболее интересные. Конечно, в ряде случаев

этот выбор был довольно субъективным, так как не имелось

данных, позволяющих сравнить эффективность различных вы-

числительных схем. Некоторые интересные методы могли ока-

заться неупомянутыми просто потому, что автор не знал об их

существовании.

Нелинейное программирование в настоящее время бурно

развивается. При выборе материала для этой книги автор ста-

рался включать то, что более или менее уже выдержало испы-

тание временем. Однако вполне возможно, что в недалеком бу-

дущем многие из обсуждаемых алгоритмов будут вытеснены но-

выми, которые окажутся лучше существующих.

Математическая подготовка, необходимая для изучения этой

книги, неодинакова для разных глав. В большинстве случаев не-

обходимы первоначальные сведения из линейной алгебры и ли-

нейного программирования (например, в пределах первых вось-

ми-девяти глав книги автора «Линейное программирование»).

Большая часть материала, относящегося к динамическому про-

граммированию, может быть изучена и без этих сведений. При

чтении третьей и шестой глав необходимо знание, хотя и не

слишком основательное, дифференциального исчисления.

Как уже говорилось, в гл 2 сделана попытка собрать все не-

обходимые для дальнейшего изложения сведения из матема-

тики. Исключение составила лишь элементарная теория вероят-

ностей, даже не упоминающаяся в этой главе, но используемая

далее в гл. 3, 5, 10 и 11.

Автор очень обязан Д. Е. Моррису, который подобрал вели-

колепные эпиграфы к каждой главе.

Рецензенты Р. Дорфман и С. Дрейфус внесли много полез-

ных предложений, за которые автор им очень благодарен. По-

мощь при перепечатывании рукописи и издании книги была

любезно оказана аспирантурой Школы бизнеса Чикагского уни-

верситета.

Дж. Хедли

Богота, Колумбия

июнь 1964 г.

ГЛАВА

ВВЕДЕНИЕ

Каждое дерзание —

Это новый риск, новый шаг в темноту

непознанного

Со старым и все более устаревающим

оснащением.

Т. С. Элиот. Восточный Колос

1.1. Задачи математического программирования. Всякая задача,

в которой отыскивается максимум или минимум числовой функ-

ции (или функционала), может быть отнесена к задачам опти-

мизации. Эти задачи уже давно интересуют математиков,

физиков и инженеров. Возможность использования методов

дифференциального и вариационного исчислений для решения

некоторых типов таких задач, возникающих в геометрии и фи-

зике, была известна с середины XVIII в.

В последние пятнадцать лет значительно возрос интерес к

новому классу задач оптимизации, которые, как правило, не

поддаются решению классическими методами. Это так называе-

мые задачи математического программирования.

Задачи математического программирования в отличие от

классических задач, возникающих в геометрии и физике, часто

относятся к вопросам математической экономики. Как правило,

они возникают в тех случаях, когда заданные дефицитные ре-

сурсы— людей, машины и сырье — следует распределить таким

образом, чтобы произвести необходимое количество продуктов

и в то же время максимизировать или минимизировать некото-

рую целевую функцию (прибыль, затраты). Большой интерес

к этим задачам объясняется именно тем, что они встречаются

не только в теоретической экономике, но и в практике производ-

ства, торговли, управления и в военном деле.

Общая задача математического программирования может

быть сформулирована следующим образом: требуется найти

значения п переменных х2, ..., хп, которые удовлетворяют m

уравнениям или неравенствам

gi(xv х2, *„)(<, =, >}fy. 1=1, 2,..., т, (1.1)

10

Гл. 1. Введение

и максимизируют или минимизируют функцию

z = f(xv х2, .. ., х„). (1.2)

Условия (1.1) называются ограничениями, а функция (1.2) —

целевой функцией. Предполагается, что функции gi(x\,x2, ..., хп)

известны, a bi — заданные константы. Кроме того, в каждом из

ограничений (1.1) сохраняется только один из знаков =

или однако разные, ограничения могут, конечно, иметь раз-

ные знаки. Величины т и п между собой не связаны, так что

т может быть больше, меньше или равно п. В частности, т мо-

жет быть и нулем, так что в рассмотрение включается и случай,

когда ограничения (1.1) отсутствуют. Обычно некоторые или

все переменные удовлетворяют условию неотрицательности.

Кроме того, в качестве ограничений может фигурировать усло-

вие, по которому часть или все переменные могут принимать

лишь некоторые дискретные, например равные целым числам,

значения.

В некоторых случаях переменные Xj сами оказываются функ-

циями одного или нескольких параметров. Задача состоит тогда

в определении функций xh х2,..., хп, оптимизирующих выраже-

ние (1.2) при условиях (1.1) и, возможно, некоторых добавоч-

ных ограничениях на функции хр

Интерес к практическому использованию- математического

программирования возрос с 1947 г., когда Дж. Данциг разрабо-

тал симплекс-метод для решения общей задачи линейного про-

граммирования *). Если в (1.1) и (1.2)

п

gi(xlt 1=1, 2, .... т, (1.3)

7=1 J J

и

п

f (Xj, х2, ..., х„) = S CjXj, (1.4)

где ац и Cj—известные константы, то задача называется линей-

ной при условии, что нет других ограничений, исключая разве

требование неотрицательности всех или части переменных.

Обычно в формулировке общей задачи линейного программиро-

0 Нелишне напомнить, что первая обстоятельная работа по линейному

программированию была выполнена еще в 1939 г. в Советском Союзе. Мы

имеем в виду «Математические методы организации и планирования произ-

водства» Л. В. Канторовича [27*]. Правда, господствовавшие тогда и в после-

дующее время взгляды на экономическую пауку надолго задержали попу-

ляризацию,' развитие и практическое использование идей Л. В. Канторовича,

в связи с чем линейное программирование и было переоткрыго в 1947 г. в

США. — Прим. ред.

1.2. Типы задач

11

вания требуется, чтобы все переменные были неотрицатель-

ными, т. е.

Xj >0, 7=1, 2, /х, (1,5)

так как такая форма задачи более удобна для численного реше-

ния. Задача, в которой некоторые переменные могут быть произ-

вольного знака, легко преобразуется в задачу с ограниче-

ниями (1.5).

Таким образом, задача линейного программирования состоит

в отыскании неотрицательных значений п переменных удо-

влетворяющих пг ограничениям

=. >\bt

J

и максимизирующих или минимизирующих линейную функцию

z = 2 cjxj

Всякую другую задачу математического программирования,

в том числе и такую, где ограничения и целевая функция имеют

вид (1.3) и (1.4), но предполагается, например, целочисленность

переменных, мы будем считать нелинейной.

В этой книге мы будем иметь дело почти исключительно с

решением задач нелинейного программирования. Методы реше-

ния нелинейных задач так или иначе включают в себя алго-

ритмы, аналогичные используемым в симплекс-методе. Поэтому

предполагается, что читатель знаком с линейным программиро-

ванием, достаточно полно изложенным в первых девяти главах

книги автора «Линейное программирование» [13]1). К сожале-

нию, задачи нелинейного программирования почти всегда ре-

шаются значительно труднее, чем задачи линейного программи-

рования,— вычислительные приемы разработаны для решения

лишь немногих типов таких задач, изучением которых мы и бу-

дем заниматься. Что касается огромного разнообразия практи-

ческих ситуаций, исследование которых приводит к задачам не-

линейного программирования (следует заметить, что в большин-

стве случаев, когда дело сводится к линейной задаче, более

детальное рассмотрение все же позволяет обнаружить нелиней-

ность), то некоторые из них будут предметом обсуждения в при-

мерах и упражнениях,

1.2. Типы задач. Большинство последующих глав посвящено

либо изучению методов решения очень специальных типов задач

нелинейного программирования, либо исследованию тех типов

’) Это примерно соответствует книге Д. Б. Юдина и Е. Г. Гольштейна

[29*]. — Прим. ред.

Г2

Гл. 1. Введение

нелинейных задач; которые могут быть решены каким-то опре-

деленным методом. Представляется желательным вначале крат-

ко рассмотреть специальные классы задач нелинейного програм-

мирования, которым будет уделено наибольшее внимание, и

общие типы вычислительных методов, полезных для решения

задач этих классов. В этом параграфе мы остановимся на клас-

сах задач, а следующий параграф будет посвящен вычислитель-

ным методам. В дальнейшем, если только это не оговорено осо-

бо, предполагается, что на переменные не наложено условие

дискретности.

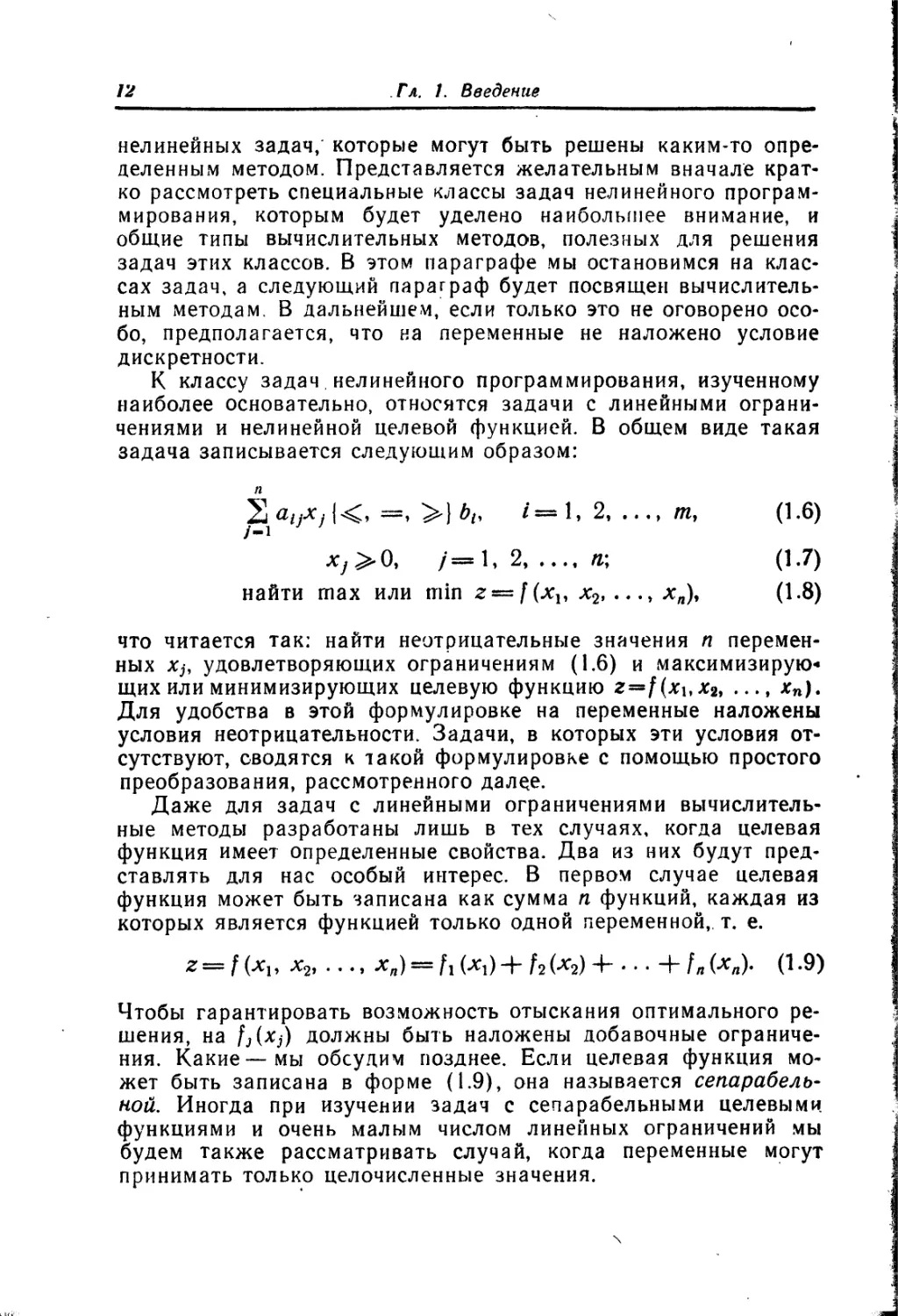

К классу задач нелинейного программирования, изученному

наиболее основательно, относятся задачи с линейными ограни-

чениями и нелинейной целевой функцией. В общем виде такая

задача записывается следующим образом:

п

/=1, 2......т, (1.6)

ху>0, /==1, 2.....я; (1.7)

найти max или min z —f (хп х2, ..хл), (1.8)

что читается так: найти неотрицательные значения п перемен-

ных Xj, удовлетворяющих ограничениям (1.6) и максимизирую*

щих или минимизирующих целевую функцию z=f(xbx2, хп).

Для удобства в этой формулировке на переменные наложены

условия неотрицательности. Задачи, в которых эти условия от-

сутствуют, сводятся к такой формулировке с помощью простого

преобразования, рассмотренного далее.

Даже для задач с линейными ограничениями вычислитель-

ные методы разработаны лишь в тех случаях, когда целевая

функция имеет определенные свойства. Два из них будут пред-

ставлять для нас особый интерес. В первом случае целевая

функция может быть записана как сумма п функций, каждая из

которых является функцией только одной переменной,, т. е.

Z=f (хи х2, . . ., Х„) = fi (Xj) + f2(X2)± • • + f „(*„) (1.9)

Чтобы гарантировать возможность отыскания оптимального ре-

шения, на fj(Xj) должны быть наложены добавочные ограниче-

ния. Какие—мы обсудим позднее. Если целевая функция мо-

жет быть записана в форме (1.9), она называется сепарабель-

ной. Иногда при изучении задач с сепарабельными целевыми

функциями и очень малым числом линейных ограничений мы

будем также рассматривать случай, когда переменные могут

принимать только целочисленные значения.

1,2. Типы задач

13

Во втором случае целевая функция может быть записана как

сумма линейной и квадратичной форм, так что

Z == / (Хь Х2...Хп) == Д CjXj -I- Д 2 citjxixj ==

==CjX1 С%Х% • • н~ СЯХЛ 4“ <1\\Х\ 4-4/12X1X2 4- ...

• • • (1\пХ\хя 4- ... 4- dnnXif (1.10)

Такие нелинейные задачи называются задачами квадратичного

программирования. Чтобы быть уверенным, что оптимальное

решение и в этом случае может быть найдено, на величины (1ц

следует наложить некоторые ограничения, которые мы не будем

сейчас рассматривать. Теории и методам решения задач квадра-

тичного программирования целиком посвящена гл. 7.

В силу многих причин, которые станут ясными в дальней-

шем, задачи с нелинейными ограничениями значительно более

трудны, чем с линейными. В дальнейшем эти задачи рассматри-

ваются, однако основное внимание здесь уделяется случаям,

в которых ограничения сепарабельны. Это означает, что функ-

ции gi(xi, х2, ..., хп) в (1.1) могут быть записаны в виде

gi(xx, х2, ..., x„) = gn(x1) 4- М + •• • + guM- (1.11)

Для того чтобы в задачах с ограничениями вида (1.11) было

возможно получение оптимального решения, на функции gtf(Xj)

и на целевую функцию должны быть наложены весьма жесткие

условия.

Имеется еще один класс задач с нелинейными ограниче-

ниями, на изучении которого мы остановимся. Задачи этого

класса относятся к классическим задачам оптимизации. Чтобы

получить о них представление, вернемся к общей задаче нели-

нейного программирования (1.1), (1.2) и допустим, что среди

ограничений нет неравенств, нет условий неотрицательности или

дискретности переменных, пг<п и функции g<(x\, х2, ..., хп) и

f(xi, х2, ..., хп) непрерывны и имеют частные производные по

крайней мере второго порядка. В этом случае задача приво-

дится к виду

^(хь х2,..x„) = djt i— 1, 2, .... m; (1.12)

найти max или min z = f(xi, x2,.... хя).

Задачи такого типа называются классическими задачами опти-

мизации. Особенность их состоит в том, что по крайней мере

в принципе эти задачи могут быть решены средствами класси-

ческих методов, основанных на использовании дифференциаль-

14

Гл. 1. Введение

ного исчисления. Однако обычно на этом пути встречаются

такие вычислительные трудности, которые делают необходимым

поиск других методов решения. В связи с этим будем рассма-

тривать классические методы не в качестве вычислительного

средства, а как теоретический аппарат, о котором важно иметь

представление, так как во многих областях он составляет основу

проводимого теоретического анализа. Например, значительная

часть экономической теории производства и поведения потреби-

теля основана на классических методах. Выделение задач

вида (1.12) в специальный класс и его изучение имеет своей

целью развитие теории классических методов оптимизации, а не

развитие вычислительных приемов для их решения. Классиче-

ские методы оптимизации изучаются в гл. 3.

Классические методы могут быть обобщены также на случаи,

когда переменные неотрицательны, а ограничения имеют вид

неравенств, однако эти обобщения имеют преимущественно

теоретическое значение и не дают конкретных вычислительных

приемов. Тем не менее мы увидим, что эти теоретические ре-

зультаты очень полезны. В случае квадратичного программиро-

вания они позволяют даже построить вычислительный метод.

Этим теоретическим обобщениям классических методов оптими-

зации будет посвящена гл. 6.

Другой класс задач нелинейного программирования, кото-

рым мы будем интересоваться, составляют задачи линейного

программирования с дополнительным требованием, чтобы пере-

менные принимали только целочисленные значения. Часто такие

задачи называют задачами целочисленного линейного програм-

мирования. Математическая формулировка их такова:

п

У аих, {<, —, >) bt, i = 1, 2, ..., tn,

Xj^O, /=1, 2, п, некоторые или все Xj — целые; (1.13)

п

найти max или min z—^CjXj.

j=i

Если все Xj должны быть целыми, то задача называется пол-

ностью целочисленной, а в противном случае — частично цело-

численной. Задачам целочисленного программирования целиком

посвящена гл. 8. Здесь изложены методы их решения и пока-

зано, что к такой постановке сводится большое число интерес-

ных задач.

Еще один класс нелинейных задач будет рассмотрен весьма

подробно. Это стохастические многошаговые задачи принятия

решений, часто встречающиеся в планировании производства,

1.3. Вычислительные методы

15

при управлении запасами и т. д. Сейчас мы не будем пытаться

привести их математическую формулировку. Скажем лишь, что

это пример того случая, когда переменные Xj являются функ-

циями других параметров.

1,3. Вычислительные методы. Симплексный алгоритм для ре-

шения общей задачи линейного программирования представляет

собой итеративную процедуру, с помощью которой точное опти-

мальное решение может быть получено за конечное число ша-

гов. Для задач нелинейного программирования вычислительный

метод, дающий точное оптимальное решение в конечное число

шагов, удается построить не всегда. Здесь часто приходится

соглашаться на использование методов, дающих только прибли-

женное решение или требующих для сходимости бесконечного

числа шагов.

Один из наиболее мощных методов решения задач, нелиней-

ного программирования состоит в преобразовании задачи ка-

ким-либо образом к виду, допускающему применение симплекс-

ного алгоритма (или одного из алгоритмов типа симплексного).

Таким образом, оказывается, что симплексный алгоритм служит

хорошим средством для решения не только линейных, но и не-

линейных задач. Природа «преобразования», с помощью кото-

рого нелинейная задача может быть приведена к форме, до-

пускающей применение симплексного метода, очень сильно

зависит от типа задачи. В некоторых случаях не требуется ни-

какой предварительной аппроксимации, в других аппроксима-

ция нужна. Однако эта аппроксимация может быть сделана

сколь угодно точной (ценой увеличения объема вычислений).

Другим полезным вычислительным методом для решения не-

которых типов задач нелинейного программирования является

динамическое программирование. Название настоящей книги

может вызвать мысль, что динамическое программирование от-

носится к специальному классу задач, отличных от задач нели-

нейного программирования. Некоторые оправдания у такого

предположения есть, так как термин «динамическое программи-

рование» часто применяется к таким задачам оптимизации,

в которых учитываются временные изменения и, следовательно,

время должно рассматриваться явно.

Здесь термин «динамическое программирование» не будет

использоваться в таком смысле. Вместо этого мы будем пони-

мать под ним вычислительный метод, использующий аппарат

рекуррентных соотношений, развитый в значительной степени

в работах Р. Веллмана. Сам термин «динамическое программи-

рование» возник в результате изучения задач математического

программирования, в которых были существенны изменения bq

16

Гл. 1. Введение

времени. Однако этот метод может быть использован и в таких

задачах, где время вообще не фигурирует, в связи с чем было

бы целесообразно ввести для него другое название. Однако тер-

мин «динамическое программирование» уже так прочно укре-

пился, что всякое его изменение трудно осуществимо.

Следует отметить, что мы используем этот термин в довольно

узком смысле: обычно мы встречаемся с ним при описании спе-

циального типа вычислительной процедуры; Впрочем, анализ

широкого класса функциональных уравнений также уклады-

вается в схему метода динамического программирования, при-

чем в этом случае он выступает не только как вычислительный,

но и как аналитический инструмент.

Последним вычислительным методом, который будет исполь-

зован, является градиентный метод. Как и симплексный метод,

он представляет собой итеративную процедуру, в которой мы

переходим шаг за шагом от одного допустимого решения к дру-

гому так, что значение целевой функции улучшается. Однако

в отличие от симплексного метода в нем не используется пере-

ход от одной вершины к другой. Вообще говоря, для сходимости

к решению здесь требуется бесконечное, число итераций.

1.4. Трудности, порождаемые нелинейностями. Прежде чем

приступить к детальному изучению специальных типов задач

нелинейного программирования, мы рассмотрим некоторые

черты нелинейных явлений, делающие эти задачи значительно

более трудными, чем линейные. Напомним, что для задач линей-

ного программирования характерно следующее:

а) Множество допустимых решений (т. е. множество всех то-

чек [хь х2, ..., хп] п-мерного пространства, удовлетворяющих

условиям (1.6) и условиям неотрицательности (1.7)) выпукло.

Это выпуклое множество имеет конечное число вершин, назы-

ваемых обычно крайними точками.

Ь) Множество всех точек [xi, х2, ..., хп] n-мерного простран-

ства, в которых целевая функция принимает заданное значение,

есть гиперплоскость. Кроме того, гиперплоскости, соответствую-

щие разным значениям целевой функции, параллельны.

с) Локальный максимум или минимум является также гло-

бальным максимумом или минимумом целевой функции на мно-

жестве допустимых решений, т. е. не существует локального

оптимума целевой функции, отличного от глобального оптимума.

(Допустимое решение доставляет глобальный (или абсолютный)

максимум целевой функции, если величина z для этого решения

по крайней мере не меньше, чем для любого другого допусти-

мого решения; допустимое решение доставляет целевой функ-

ции локальный максимум, если, грубо говоря, значение ? для

1.4. Трудности, порождаемые нелинейностями

17

этого допустимого решения больше, чем значение z для близких

допустимых решений.)

d) Если оптимальное значение целевой функции ограничено,

то по крайней мере одна крайняя точка множества допустимых

решений является оптимальным решением. Кроме того, начав

с произвольной вершины множества допустимых решений, мож-

но достичь оптимальной крайней точки в конечное число шагов,

причем на каждом шаге' совершается переход только в сосед-

нюю вершину. Окончательно, данная вершина является опти-

мальной тогда и только тогда, когда значение целевой функции

в ней по крайней мере не меньше, чем значения целевой функ-

ции во всех примыкающих вершинах.

У произвольной задачи нелинейного программирования неко-

торые или все эти свойства, характеризующие линейные задачи,

отсутствуют.

Задачи, содержащие только две переменные, легко могут

быть решены графически. Мы приведем сейчас несколько таких

графических примеров, чюбы проиллюстрировать более на-

глядно разницу между линейными и нелинейными задачами.

Рассмотрим сначала следующую задачу линейного программи-

рования:

*1 + х2 'С 6,

*1 — х2 < 1,

2х1 + х2>6, <1Л4>

0,5%! — х2 > — 4,

Xi > 1, х2 > 0;

найти max z = CUJxj + 2х2.

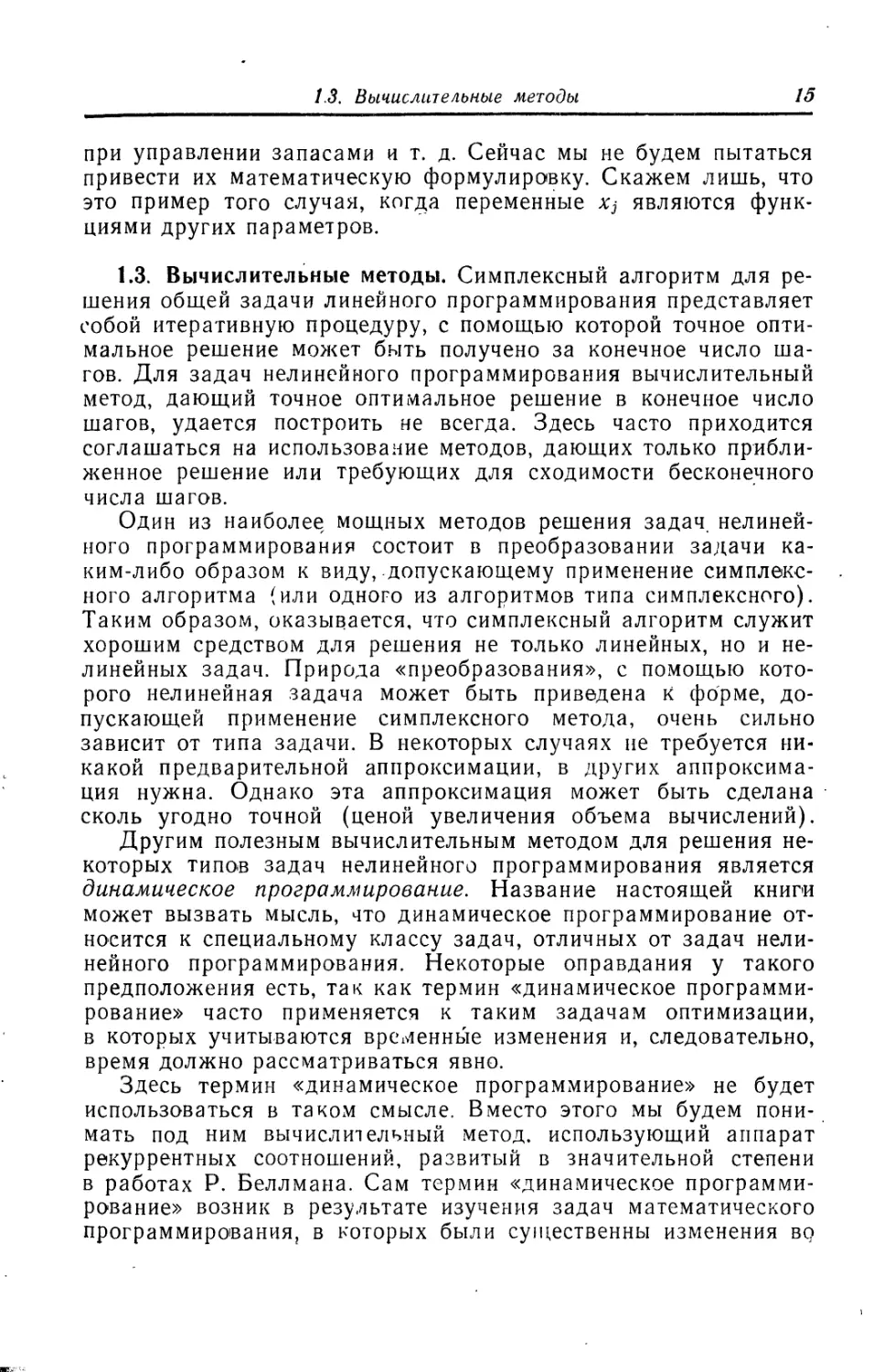

Графическое решение показано на рис. 1.1. Область допусти-

мых решений заштрихована. Оптимум достигается в вершине.

Значения переменных, доставляющих максимум целевой функ-

ции, единственны и являются координатами точки пересечения

линий Xi+X2 = 6, 0,5*1—х2 = —4. Оптимальные значения пере-

менных есть х* = 4/3, х* = 14/3. Максимальное значение целе-

вой функции г* =10.

Рассмотрим теперь задачу нелинейного программирования,

которая отличается от предыдущей только тем, что целевая

функция имеет вид

г=10(х1 — 3,5)2 + 20(х2 — 4)2. (1.15)

Пусть решается задача на минимум. Заметим, что здесь мы

имеем сепарабельную целевую функцию и решаемая задача

имеет вид (1.6) — (1.9). Графическое решение задачи дано на

2 Зц«. 735

18

Гл. 1. Введение

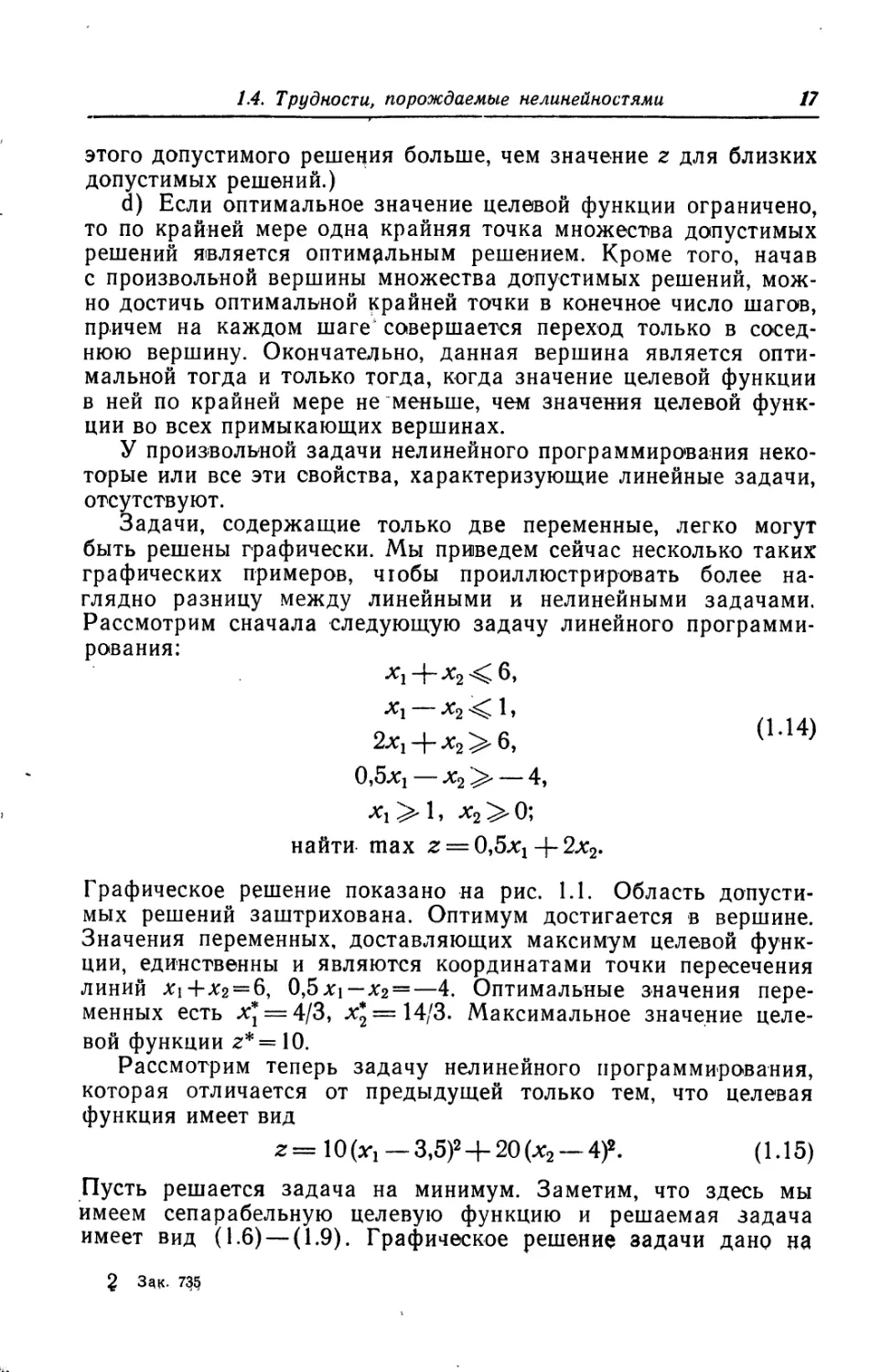

рис. 1.2. Область допустимых решений, конечно, та же самая,

что и в предыдущем примере. Здесь, однако, линии уровня функ-

ций z являются эллипсами с центрами в точке %i = 3,5, х2=4.

Оптимальное решение есть точка, в которой эллипс касается

границы выпуклого множества. Если обозначить оптимальные

значения переменных через х* и х*. а минимальное значение

целевой функции через г*, то из рис. 1.2 следует, что х* -рх* = 6

и г*=10(х*— 3,5)2-|-20(х* — 4)2. Кроме того, тангенс угла на-

клона касательной к кривой z* = 10(xi~3,5)2 + 20(х2—4)2 в точке

(х*, х*) должен равняться —1, так как таков он у прямой

Х1 + Х'2 = 6. Таким образом, мы получаем дополнительное уравне-

ние х* — 4 = 0,5(х*— 3,5). Всего же, следовательно, имеется

3 уравнения относительно х*, х* и z*. Их единственное решение

есть х* = 2,5, х* = 3,5, z*= 15. Точка, в которой целевая

функция принимает наименьшее значение, лежит на границе

множества допустимых решений, но не в крайней точке этого

множества. Следовательно, не существует вычислительной про-

цедуры для задач такого типа, которая ограничивалась бы пере-

бором только вершин множества допустимых решений.

Небольшая модификация уже рассмотренной целевой функ-

ции может привести к тому, что минимальное значение дости-

1.4. Трудности, порождаемые нелинейностями

19

гается во внутренней точке этого, множества. Пусть, например,

целевая функция имеет вид

г == 10 (Xj — 2)2 + 20 (х2 — З)2, (1.16)

а множество допустимых решений то же, что и раньше (см.

рис. 1.3). Оптимальные значения xi9 х2 и z есть х* = 2, х* = 3,

z* = 0. Таким образом, оптимизирующая точка не обязательно

лежит на границе. Отметим, что в рассмотренном случае мини-

мум целевой функции при наличии ограничении и условий не-

отрицательности тот же, что и без них. В таких случаях мы бу-

дем говорить, что ограничения несущественны.

В каждом из рассмотренных примеров локальный оптимум

совпадал с глобальным. Легко, однако, привести примеры, где

это будет не так. Рассмотрим следующую задачу с линейными

ограничениями и сепарабельной'целевой функцией (рис. 1.4):

Xi -|- х2 2,

Xj — х2 —2,

%1 4~Х2 6,

— Зх2 < 2,

хп х2 > 0;

найти max z — 25 (Xj — 2)2 -|- (х2 — 2)2.

20

Гл. 1. Введение

Нетрудно понять, что в вершине 4 достигается глобальный

максимум целевой функции. Вместе с тем в вершине 2 дости-

гается относительный максимум целевой функции, отличный от

глобального (значение целевой функции в точке 2 больше, чем

значения ее в соседних вершинах 1 и 3).

Здесь мы имеем случай, когда глобальный экстремум цеЛе-

вин функции достигается в вершине выпуклого множества до-

IА. Трудности, порождаемые нелинейностями

21

пустимых решений. Кроме того, существует другая вершина,

в которой достигается относительный экстремум (по отношению

к соседним вершинам), отличный ог глобального. Следует отме-

тить, что в задачах такого типа глобальный экстремум дости-

гается в вершине, однако нет возможности использовать вы-

числительную процедуру симплексного типа (основанную на

переходе от одной вершины к соседней, которая оканчивалась

бы при достижении вершины, доставляющей относительный экс-

тремум целевой функции по сравнению со всеми соседними вер-

шинами. Такая процедура может привести к относительному, но

не обязательно к глобальному оптимуму.

Если задача содержит нелинейные ограничения, то не сохра-

няет силу утверждение о выпуклости области допустимых реше-

ний. Более того, она может даже состоять из нескольких несвя-

занных областей. Пусть, например, ограничения имеют вид

(Xj —1)Х2<1,

(1-18)

X] —1~ х2 3,5,

и переменные должны быть неотрицательны. Множество до-

пустимых решений в этом случае состоит из двух отдельных

частей, ни одна из которых не выпукла (рис. 1.5). Если мно-

жество допустимых решений не выпукло, то может существовать

отличный от глобального локальный оптимум даже при линей-

ной целевой функции.

22

Гл. Введение

Для- задач нелинейного программирования, имеющих отлич-

ные от глобального локальные оптимумы, большинство вычисли-

тельных методов, которые мы будем рассматривать, позволяет

найти точку именно локального оптимума. В общем случае они

не позволяют установить, совпадает л.и она с точкой глобаль-

ного оптимума. Тем не менее эти методы отыскания локального

оптимума часто оказываются очень полезными на практике.

Единственный вычислительный метод, приводящий к глобаль-

ному оптимуму независимо от числа локальных экстремумов,—

это метод динамического программирования. Следовательно,

если задача может быть решена с помощью динамического про-

граммирования, мы всегда получаем возможность отыскать гло-

бальный оптимум.

Последней мы рассмотрим следующую задачу целочислен-

ного программирования (рис. 1.6):

ОДлх-г х2< 1,75,

^ + 0,30X2 <1,50, (1Л9)

хн аг2:>0, Хр х2— целые;

найти max z = 0,25%! 4-х2.

Заштрихованная область была бы выпуклым множеством допу-

стимых решений при отсутствии целочисленных ограничений.

1.5. Краткий исторический обзор

23

При учете требования целочисленности переменных Xj имеется

лишь четыре допустимых решения, изображенных кружочками

на рис. 1.6. Если игнорировать требования целочис/Лшости, то

решение соответствующей задачи линейного программирова-

ния есть х* = 0, х*=1,75, г*—1,75. Однако при учете цело-

численности оптимальным решением будет •х*=1, х*=1,

1,25. Отметим, что это решение не совпадает с тем, которое

было бы получено путем решения задачи линейного программи-

рования с последующим округлением результатов до ближай-

ших целых, удовлетворяющих ограничениям (таким путем мы

получили бы Xi = 0, л'2=1 иг=1).

1.5. Краткий исторический обзор. Уже было отмечено, что

искрой для феноменального роста интереса к теории и практике

математического программирования послужило открытие в

1947 г. вычислительного метода для решения задач линейного

программирования. Этот численный метод, названный симплекс-

методом, был разработан Данцигом, когда он был членом груп-

пы 15уда, работавшей над некоторыми типами задач математи-

ческого программирования для ВВС США. Хотя метод и был

разработан в 1947 г., широко известен он стал лишь со времени

опубликования в 1951 г. книги [16].

Интерес к нелинейным задачам рос одновременно с интере-

сом к линейному программированию. В 1951 г. Кун и Таккер

опубликовали работу [17], в которой приведены необходимые и

достаточные условия оптимальности для решений нелинейных

задач. Эта важная работа послужила основой для многих по-

следующих работ в нелинейном программировании. Некоторые

обобщения их теоретических исследований, сделанные другими

авторами, появились позднее в книге, изданной в 1958 г. под

редакцией Эрроу, Гурвица и Удзавы (см. [1]).

В 1954 г. Чарнс и Лемке опубликовали приближенный метод

решения задач с сепарабельной выпуклой целевой функцией и

линейными ограничениями [6]. Альтернативная формулировка

этой задачи была дана Данцигом [7]. Позднее этот метод был

обобщен Миллером [21] на случай сепарабельных ограничений.

Начиная с 1955 г. начало появляться большое число работ раз-

личных авторов, посвященных квадратичному пограммированию.

Сюда относятся работы Баранкина и Дорфмана [2] (1955).

Била [3] (1955), Франк и Вольфа [10] (1956), Марковица [19]

(1956), Хилдрета [14] (1957), Хаутеккера [15] (1957) и Вольфа

[23] (1959). Еще ряд работ появился после 1959 г. Все перечис-

ленные работы, за исключением статьи Баранкина и Дорфмана,

содержали мало отличающиеся между собой вычислительные

методы для решения задач квадратичного программирования.

24

Гл. 1. Введение

Наиболее известным среди них является метод, предложенный

Вольфом. Его преимущество состоит в том, что он приводит за-

дачу к форме, допускающей применение симплекс-метода. По-

дробно этот метод будет рассмотрен в гл. 7.

Интерес к целочисленным решениям задач линейного про-

граммирования появился в начале раз-Ьития математического

программирования. Одна из первых работ, посвященных этому

вопросу, было опубликована Данцигом, Фалкерсоном и Джонсо-

ном [8] в 1954 г. В более поздней работе Марковица и Манне [20)

обсуждались вычислительные методы и, кроме того, были приве-

дены некоторые типы нелинейных задач, сводящихся к целочис-

ленному программированию. Хотя эти работы и содержат вы-

числительные приемы для решения задач целочисленного про-

граммирования, первым по сути дела оказался Гомори [11, 12],

так как им был разработан вычислительный метод, приводивший

к оптимальному решению за конечное число итераций. Это было

сделано в 1958 г. для полностью целочисленной задачи и в

1960 г. — для частично целочисленной.

История динамического 'программирования тесно связана с

именем Р. Веллмана, сделавшего самый большой вклад в раз-

витие этого метода и опубликовавшего свои результаты за

50-е годы более чем в 100 статьях. Итоги его работы содержатся

в книге «Динамическое программирование» [4] и в написанной

им вместе с Дрейфусом книге «Прикладные задачи динамиче-

ского программирования» [5].

Градиентные методы уже давно интересуют математиков и

физиков. Внимание на возможность их использования для реше-

ния задач нелинейного программирования было обращено в уже

упоминавшейся книге [1]. Деннис [9], по-видимому, одним из

первых предложил вычислительный алгоритм, хотя и не разра-

ботанный в деталях. Позднее несколько различных алгоритмов

были развиты Зойтендейком [24] и Розеном [22]. Большое коли-

чество работ, посвященных этому вопросу, появилось в послед-

нее время.

Этот краткий исторический обзор доводит нас до 1962 г. Мы

не делаем попытки проследить развитие классических методов

оптимизации, берущих свое начало в XVIII в. Свой вклад сюда

г несли такие великие математики, как Ньютон, Лагранж, Бер-

нулли, Гамильтон и Вейерштрасс.

В этом очень кратком историческом обзоре мы перечислили

лишь те работы, которые представляются наиболее важными

сегодня. Следует сказать, однако, что нелинейное программиро-

вание находится еще в состоянии непрерывного развития, и

история, написанная несколькими годами позже, возможно, от-

метит совсем другие факты. Точно так же некоторые или даже

1.6. Обзор дальнейшего содержания

25

все вычислительные методы, рассматриваемые в этой книге, мо-

гут быть вытеснены более эффективными в не очень далеком

будущем.

1.6. Обзор дальнейшего содержания. В следующей главе мы

рассмотрим некоторые вопросы линейной алгебры, линейного

программирования и анализа, которые нам понадобятся в даль-

нейшем. Главная цель этой главы — ввести обозначения и слу-

жить кратким справочником. В большинстве случаев доказа-

тельства не приведены, так как предполагается, что читатель

более или менее знаком с материалом.

В гл. 3 рассматриваются классические методы оптимизации.

Здесь же рассмотрены свойства выпуклых и вогнутых функций.

Глава 4 посвящена изучению задач нелинейного программи-

рования с сепарабельными целевыми функциями и ограниче-

ниями.

В гл. 5 изучаются задачи стохастического программирования,

т. е. такие, в которых некоторые параметры являются случай-

ными.

В гл. 6 обсуждается работа Куна и Таккера, посвященная

обобщению классических условий оптимальности на задачи с

ограничениями типа неравенств и условиями неотрицательности

переменных.

В гл. 7 эти результаты применяются для изучения задач

квадратичного программирования. С их помощью здесь обосно-

вывается метод Вольфа. Другие вычислительные методы рас-

сматриваются весьма кратко. Обсуждаются также вопросы

двойственности в применении к задачам квадратичного програм-

мирования.

В гл. 8 рассматривается целочисленное линейное программи-

рование и алгоритмы Гомори обобщаются на случай полностью

и частично целочисленных задач. Здесь также показано, что

многие интересные задачи нелинейного программирования мо-

гут быть сведены к целочисленным.

В гл. 9 изучается несколько типов градиентных методов для

решения задач нелинейного программирования.

Главы 10 и 11 посвящены динамическому программирова-

нию. Так как этот термин относится скорее к вычислительной

методике, чем к специальному типу задач, в этих главах рас-

сматриваются довольно разнообразные задачи. Показано, что

динамическое программирование можно, по крайней мере теоре-

тически, использовать для решения многих задач нелинейного

программирования. Мы увидим, однако, что имеются строгие

ограничения на типы задач, которые могут быть решены чис-

ленно.

26

Гл. 1. Введение

ЛИТЕРАТУРА')

1. Э р р о у К. Дж., Гурвиц Л., У д з а в а X., Исследования по линейному

и нелинейному программированию, ИЛ, М., 1962.

2. В а г а п к i n Е. W., Dorfman R., Towards Quadratic Programming,

Office of Naval Research Logistics Projects at Columbia University and

University of California, Berkeley, 1955.

3. Beale E. M. L., On Minimizing a Convex Function. Subject to Linear

Inequalities, J. Roy. Statist. Soc. (B), 17 (1955), 173—184.

4. Веллман P., Динамическое программирование, ИЛ, M., 1960.

5. Веллман Р., Дрейфус С., Прикладные задачи динамического про-

граммирования, изд-во «Наука», М., 1964.

6. С h а г n е s A., L е m k е С., Minimization of Nonlinear Separable Convex

Functionals, Nav. Res. Logist. Quart., 1 (1954), 301—312.

7. D a n t z i g G. B., Recent Advances in Linear Programming, Manag. Sci.,

2 (1956), 131 — 144.

8. D a n t z i g G. B., Fulkerson D. R., Johnson S., Solution of a Large-

Scale Traveling-Salesman Problem, J. Operat. Res. Soc. Amer., 2 (1954),

393—410.

9. Деннис Дж. Б., Математическое программирование и электрические

цепи, ИЛ, М., 1961.

10. Frank М., Wolfe Р., An Algorithm for Quadratic Programming, Nav.

Res. Logist. Quart., 3 (1956), 95—110.

11. G о m о г у R., Essentials of an Algorithm for Integer Solutions to Linear

Programs, Bull. Amer. Math. Soc., 64 (1958), 275—278.

12. Go mor у R., An Algorithm for the Mixed Integer Problem, RM-2597,

RAND Corp., 1960.

13. Had Ге у G., Linear Programming, Reading, Addison-Wesley, 1962.

14. Hildreth C., A Quadratic Programming Procedure, Nav. Res. Logist.

Quart., 14 (1957), 79—85.

15. Houthakker H., The Capacity Method of Quadratic. Programming,

Econometrica, 28 (1960), 62—87.

16. Koop mans T. (ed.), Activity Analysis of Production and Allocation,

New York, Wiley, 1951.

17. Kuhn H. W., Tucker A. W., Nonlinear Programming, Proc. Second

Berkeley Symp. on Math. Statistics and Probability, 1951, 481—492.

18. Lemke C., The Constrained Gradient Method of Linear Programming,

J. Soc. Indust, and Appl. Math., 9 (1961), 1—17.

19. Markowitz H., The Optimization of a Quadratic Function Subject to

Linear Constraints, Nav. Res. Logist. Quart., 3 (1956), 111 —133.

20. Ma rkowitz H., Manns A. S., On the Solution to Discrete Programm-

ing Problems, Econometrica, 25 (1957), 84—110.

21. Miller С. E., The Simplex Method for Local Separable Programming,

in Graves R., Wolfe P. (ed.), Recent Advances in Mathematical Pro-

gramming, New York, McGraw-Hill, 1963.

22. Rosen J., The Gradient Projection Method for Nonlinear Programming.

Part I. Linear Constraints, J. Soc. Indust, and Appl. Math., 9 (1960), 181—217.

23. Wolfe P., The Simplex Method for Quadratic Programming, Econometri-

ca, 27 (1959), 382—398.

24. Z о u t e n d i j k G., Maximizing a Function in a Convex Region, J. Roy.

Statist. Soc. (B), 21 (1959), 338—355.

25* . Гол ьштейн E. Г., Юдин Д. Б., Новые направления в линейном про-

граммировании, изд-во «Советское радио», М., 1966.

J) Звездочкой отмечены названия, включенные переводчиками и редак-

тором перевода. — Прим. ред.

Упражнения

27

26*. 3 о й т е н д е й к Г., Методы возможных направлений, ИЛ, М., 1963.

27*. Канторович Л. В., Математические методы организации и .планиро-

вания производства, Л., 1939.

28*. Канторович Л. В., Об одном эффективном методе решения некото-

рых классов экстремальных проблем, ДАН СССР, 28 (1940), № 3, 212—

215.

29*. Юлин Д. Б., Гольштейн Е. Г., Задачи и методы линейного про-

граммирования. изд-во «Советское радио», М., 1961.

30*. Graves R., Wolfe Р. (ed.), Recent Advances in Mathematical Pro-

gramming, New York, McGraw-Hill, 1963.

Упражнения

РенЙгть следующие задачи нелинейного программирования и проиллю-

стрировать их с помощью геометрических построений:

1.1. 0,5%) -|~х2 < 4,

3х । х 2 4$^ 15,

Х| -j— Л" 2 1,

хн х2 > 0;

найти min z — 4 (хх — 6)2 6 (х2 — 2)2.

1.2. 0,5х, 4-х2 4,

Зх] —|— х2 15,

хи х2 >> 0;

найти max z — 3 (хх — 1,5)2 4- 6 (х2 — 1,5)2.

1.3. xt — х2 > 0,

Xj + *2 < 4,

Xj < 3; х-

найти max и min г = 2хг -f- Зх2 + 4х? -|- 2хгх2 +

1.4. (Xi— 2)2 + (х2—1)2<9,

Xi , х2 >> 0;

найти max z — 3xi -ф- 2х2.

1.5. х{х2 1,

Х14“ Л2 9;

найти min z — 7 (xj — 6)2 -}- 3 (х2 — 4)2.

28

Гл, 1. Введение

1.6. ххх2 1,

*14--«2<9,

*i<2,

х(, х2>0;

найти max z «* 8л^ 4* 2*1

1.7.

4“ *2 3,

хь х2>0;

найти min г ~ 6 (X) — 5)2 4“ (*г — 4)*.

1 -8. Зх । 4" 2х2 9,

** 0.5х । 4- *2 < 4,

Х|, х2 >0;

найти max-г = х,х2.

1.9. (лг, — 3) (л;2 — 3) » 1

Х|. *2>0;

найти max и min^»^—2,5)24-С*г— 3,5)*.

1.10. (Х, _ 3)(х2 —3)< 1,

хь х2>0;

найти min z ® (*, — 6)2 4* (*г — 8)2.

111. Х| 4~*2<5’

0,Зх} 4* 3>

Х|. х2 >0;

найти max и min z » 5х\ 4"3х1 — 4л2.

1.12. 2л( — х2>0,

0,5*! — х2 < 0,

*1 4- *2 < 5,

х{, х2>0, х{ и х2—-целые;

найти max z » 4xj 4~ Зх2.

1.13. 2Х| — х2 > О,

0,5Х|—х2<0.

х} + х2 < 5,

*2 > 9, х} — целое. х2 — непрерывно;

найти max z 4х} 4е

ГЛАВА 2

НЕОБХОДИМЫЙ МАТЕМАТИЧЕСКИЙ АППАРАТ

Все, что случилось с нами, лишь пролог

К тому, что мы с тобой должны свершить.

Шекспир. Буря

2.1. Матрицы и векторы. Справочный материал, излагаемый

в этой главе, касается линейной алгебры и линейного програм-

мирования. Подробное изложение этих вопросов читатель най-

дет в работах автора «Линейная алгебра» [3] и «Линейное про-

граммирование» [4] *). В дальнейшем мы будем часто ссылаться

на эти работы. Для удобства ссылок примем сокращенные обо-

значения: так, {ЛА 3.6} будет означать ссылку на § 6 3-й главы

книги «Линейная алгебра»; при ссылке на книгу «Линейное

программирование» вместо ЛА будем писать ЛП.

Под матрицей мы будем понимать прямоугольную таблицу

действительных чисел. Эти числа называются элементами мат-

рицы. Для обозначения матриц обычно используют заглавные

буквы, например А, В и т. д. Элементы матрицы мы будем обо-

значать малыми буквами, имеющими двойной индекс, напри-

мер atj, bij. Таким образом, мы можем записать

а12 • •. а1л

#21 #22 • • * #2л

А-|1М“ • » •

_#/и1 #т2 • • • ^тп

(2,1)

Матрицу можно задать, указав ее общий элемент. В этом слу-

чае мы используем обозначение ||а<>||. Матрица А в (2.1) назы-

вается матрицей с размерами тХп — она имеет т строк и

п столбцов. Первый индекс элемента а^ означает номер строки,

') Необходимые сведения по линейному программированию советский чи-

татель может найти в упоминавшейся в гл. 1 книге Д. В. Юдина и

Е. Г. Гольштейна. — Прим. ред.

30

Гл. 2. Необходимый математический аппарат

а второй — номер столбца, в которых находится этот элемент.

Если т = п, то говорят, что матрица квадратная и имеет поря-

док п.

Две матрицы А и В считаются равными (А=В) тогда и

только тогда, когда все их соответствующие элементы равны,

т. е. a^ = bij для всех i и /. Чт.обы сложить две матрицы с раз-

мерами mXn, необходимо сложить их соответствующие эле-

менты; сумма матриц А и В обозначается через А + В. Сложе-

ние матриц подчиняется ассоциативному и коммутативному

законам

АЧ-В4-С = (А4-В) + С = А + (В4-С) и А4-В = В4-А.

В дальнейшем мы часто будем называть действительные

числа скалярами. Произведение матрицы А на скаляр X (пи-

шется ЛА или АЛ) получается умножением каждого элемента

матрицы А на Л:

XA = ||U0||.

Заметим, что А + А = 2А и если А = В, то ЛА = ЛВ. Вычитание

матриц можно определить, пользуясь уже введенными поня-

тиями:

А —В = А-Н—1)В.

Произведение АВ матриц А и В может быть определено

лишь тогда, когда число столбцов матрицы А равно числу строк

матрицы'В. Если А — матрица с размерами тХг, а В — с раз-

г

мерами гХп, то С==АВ имеет размеры тХп и S aikbkj.

k^i 7

Умножение матриц ассоциативно,

АВС = (АВ) С == А (ВС),

но в общем случае не коммутативно, так что АВ не всегда рав-.

но ВА.

Матрица называется нулевой, если все ее элементы равны

нулю. Нулевая матрица обозначается символом 0. Если соот-

ветствующие операции выполнимы, то

А + О = А = О+А и А0 = 0А = 0.

В общем случае из равенства АВ = 0 не следует, что либо

А = 0, либо В = 0. Существуют ненулевые матрицы, произведе-

ние которых равно нулевой матрице.

Квадратная матрица называется диагональной, если < 0^ = 0

при i=/=j; говорят, что элементы ац лежат на главной диагонали

матрицы (идущей из левого верхнего угла в правый нижний

2.1. Матрицы и векторы

31

угол). Диагональная матрица, для которой все ац равны между

собой, ац = к, называется скалярной матрицей. Если воспользо-

ваться символом Кронекера который равен 0, если /=£/, и

единице, если i~j, то диагональная и скалярная матрицы могут

быть записаны в виде Наиб^Н и Между множеством всех

скалярных матриц ||Хб^|1 порядка п и множеством всех действи-

тельных чисел л имеется полная аналогия. Квадратная матрица

1 = ||6^|| называется единичной матрицей. Иногда, чтобы указать

порядок единичной матрицы, мы будем символ I снабжать ниж-

ним индексом, например 1п. В единичной матрице единствен-

ными элементами, отличными от нуля, являются элементы глав-

ной диагонали; эти элементы равны единице. Таким образом,

например,

Г1 О

1з= 0 1

~0 О

О’

о

1 _

Если А —матрица с размерами тХм, то IwA = AIn = A. Кроме

того, 11 = 1.

Матрицей, транспонированной для матрицы А с размерами

тХп, называется матрица с размерами пХ/п, получающаяся

из А заменой строк на столбцы. Таким образом, первая строка

матрицы А становится первым столбцом транспонированной

матрицы и т. д. Матрица, транспонированная для матрицы А,

обозначается через Az. Если Az = || а'.. ||, то = ajr .Нам бу-

дут полезны следующие свойства:

(A + B)Z = AZ + BZ,

• (AZ)Z = A, (AB)Z = B AZ. .

Отметим, что матрица, транспонированная для произведения

матриц, равна произведению транспонированных матриц-сомно-

жителей, взятых в обратном порядке {ЛА 3.7}. Квадратная

матрица А называется симметрической, если A = AZ, т. е. ац—ац.

Квадратная матрица А называется кососимметрической, если

А = —Az, т. е. ао = —ац~0.

Если мы в матрице А с размерами mXn вычеркнем все

строки и столбцы, кроме выбранных t строк и и столбцов, то в

результате мы получим матрицу с размерами tXu, которая на-

зывается подматрицей матрицы А. В некоторых случаях, напри-

мер для иллюстрации особенностей структуры матрицы или для

упрощения умножения матриц, удобно разбивать матрицу на

подматрицы .(блоки). Такое разбиение можно осуществить, про-

ведя разбивающие прямые между выбранными строками и

32

Гл. 2. Необходимый математический аппарат

столбцами. Так, например, выглядит одно из возможных раз-

биений матрицы с размерами 4X4:

#12 #13 i #14

А — #21 #22 #23 • #24 ГАп

л — #31 #32 #33 : #34 LA21

— #41 #42 #43 i #44-

Л12

^22

Получившиеся в результате разбиения блоки мы обозначили

через Aij. Если существует произведение АВ матриц А и В, то

это произведение может быть вычислено с помощью блочного

умножения при условии, что столбцы матрицы А и строки

матрицы В разбиты одинаковым образом. При этом сам способ

разбиения не имеет значения. Например, если произведение АВ

существует и столбцы матрицы А разбиты тем же способом, что

и строки йатрицы В, так что

Вп

и В = В21

-В31 -

Ап А12 А13

-A2i А22 А23

А =

то

АВ АцВц + А12В214- А13В31

L А21ВП+а22в21+а23в31 j

Более подробно разбиение матриц рассматривается в {ЛА 3.9}.

Матрицы, состоящие из одной строки или одного столбца,

часто называют векторами. Матрица, состоящая из одной стро-

ки, называется вектором-строкой, а матрица, состоящая из од-

ного столбца, — вектором-столбцом. Вектор-строку мы будем

записывать в виде а= (#ь ..., #п), а вектор-столбец — в виде

а=[#ь ..., ап]. Вектор (#ь ..., ап) или [#ь ..., ап} называется

n-мерным, а число #; — его i-й компонентой или координатой. ,

В дальнейшем нам придется иметь дело в основном с векто- I

рами-столбцами. Поэтому ниже, если не оговорено противное, j

мы будем считать всякий вектор вектором-столбцом. Часто мы

будем рассматривать такое разбиение матрицы А с размерами

/иХп, что каждая ее подматрица совпадает с одним из ее столб-

цов, т. е. матрица А в этом случае представляет собой строку I

векторов-столбцов. Если столбцы матрицы А обозначить через j

а> = [#и, ...» ОтпД то A=(ai, ..., ап). Аналогично матрицу A ।

можно представить в виде столбца из векторов-строк. Если

строки матрицы А обозначить через а^=(#гь ain), тО’ |

А = [а!, ат]. I

2.1. Матрицы и векторы

3$

Часто удобно n-мерный вектор понимать как точку в ц-мер-

ном пространстве. Таким образом, геометрической интерпрета-

цией вектора является точка. В этом смысле вектор-строка и

вектор-столбец не различаются. Используя геометрический язык,

мы будем поэтому часто векторы называть точками. В двумерт

ном и трехмерном пространствах вектор удобно представлять

в виде направленного отрезка, идущего из начала координат

в точку, характеризующую вектор. В этом случае легко могут

быть проиллюстрированы такие операции над векторами, как

умножение на скаляр (рис. 2.1) и сложение (рис. 2.2).

Чтобы показать, что n-мерное пространство, являющееся

совокупностью всех n-мерных векторов, обладает свойствами,

аналогичными свойствам обычных двумерных и трехмерных

пространств, введем для этого пространства понятия системы

координат и расстояния. Для этого рассмотрим п п-мерных

векторов

в1 =-[1, 0, 0], е2 = [0, 1, 0,0], ...» ей = [0, 0, 0, 1],

называемых единичными векторами. Тогда любой n-мерный век-

тор может быть записан в виде

а == [ап ..., ап\ — -]-•••+ cint}V (2.2)

Говорят, что вектор а является линейной комбинацией дан-

ных векторов аь ..., а&, если существуют такие скаляры Х;-, что

k

a-^S^Ar Из равенства (2.2) видно, что любой n-мерный векг

тор может быть представлен как линейная комбинация единич-

ных векторов. Единичные векторы могут быть использованы для

определения системы координат: оси координат в этой системе

3 Зак. 735

34

Гл. 2. Необходимый математический аппарат

определяются началом координат 0 = [0, 0, 0] и каждой из

точек е,.

Скалярным произведением двух n-мерных векторов а и Ь

п

называется число S afi^ Если а и b — векторы-столбцы, то это

число можно записать как произведение матриц а'Ь (мы не бу-

дем отличать матрицу, состоящую из одного элемента, от соот-

ветствующего действительного числа). Если а — вектор-строка,

а b — вектор-столбец, то их скалярное произведение может быть

записано в виде ab. Отметим, что для векторов-столбцов а'Ь = Ь'а

и для любого скаляра Л (Ла')Ь = а'(ЛЬ) =Х(а'Ь). Расстояние

|а—Ь| между двумя точками (векторами) а и b определяется

следующим образом:

| а — Ь | = [(а — Ь)' (а — Ь)]1/2 =

п

(2.3)

Это определение расстояния является прямым обобщением опре-

деления расстояния в двумерных и трехмерных пространствах.

Длиной или абсолютной величиной |а| вектора а называется

расстояние от начала координат до точки а: |а| = |а — 0j. Сово-

купность всех n-мерных векторов ..., ап] вместе с расстоя-

нием, определенным выражением (2.3), будем называть п-мер-

ным евклидовым пространством и обозначать символом Еп.

Символы Е2 и Е3 означают обычные двумерные и трехмерные

пространства, рассматриваемые в аналитической геометрии.

Для любых двух n-мерных векторов а и b справедливо нера-

венство |а'Ь|<Ца| |Ь|, где |а'Ь( —абсолютная величина скаляр-

ного произведения. Это неравенство известно под названием не-

равенства Шварца1). Если а, Ь¥=0, то угол 0 между векто-

рами а и Ь определяется соотношением

cos0==T^TbT’ (2-4)

Вследствие неравенства Шварца |cos0|-<l, и мы всегда можем

определить угол 0 так, что О^0^л. В Е2 и Е3 это угол между

направленными отрезками, соответствующими векторам а и Ь

{ЛА 2.3}. Два вектора называются ортогональными, если а'Ь = 0.

Таким образом, если а, Ь=#0, то они ортогональны тогда, когда

угол между ними равен л/2. Единичные векторы ортогональны:

е<еу. = 0, /=£ / Система координат, определяемая единичными

векторами, называется ортогональной.

9 В советской математической литературе указанное соотношение обыч-

но называется неравенством Буняковского. — Прим. ред.

2.1. Матрицы и векторы

35

Примем обозначения: а>Ь означает, что /=1, ..., п

и а>Ь — что aj>bh /=1, .... п.

Векторы аь ..., afe называются линейно зависимыми, если

существуют числа Xj, не все равные нулю, такие, что

*

2М/ = 0; (2.5)

в противном случае векторы называются линейно независимыми.

Если векторы линейно независимы, то соотношение (2.5) выпол-

няется лишь тогда, когда BceXj=0, /=1, ..., k. Конечное мно-

жество векторов является линейно зависимым тогда и только

тогда, когда один из векторов может быть представлен в виде

линейной комбинации остальных {ЛА 2.7}. Если множество, со-

стоящее из k векторов, линейно независимо, то любое •подмно-

жество этого множества также линейно независимо. Говорят,

что число г является максимальным числом линейно независи-

мых векторов для некоторого множества, если в этом множестве

имеется по крайней мере одно подмножество, состоящее из г ли-

нейно независимых векторов, и нет ни одного подмножества, со-

держащего г+1 линейно независимых векторов. Нулевой вектор

линейно зависим по отношению ко всем остальным векторам, и

множеств линейно независимых векторов, содержащих его, не

существует. Единичные векторы линейно независимы, так как

п

из равенства •••> ^л]=0 следует, что Х? = 0,

/-1

/ = 1, ..., п.

Говорят, что множество векторов а1э..., аг из Еп порождает

пространство Еп, если любой вектор, принадлежащий Еп, мо-

жет быть представлен в виде линейной комбинации векторов

ai, ..., аг. Базисом Е” называется линейно независимое под-

множество векторов из Еп, порождающее все пространство. Из

предыдущего ясно, что единичные векторы представляют собой

базис Еп. Любое множество векторов, образующих базис в про-

странстве Еп, может быть использовано для введения в нем си-

стемы координат. Представление любого вектора в виде линей-

ной комбинации базисных векторов единственно {ЛА 2.8}.

В линейном программировании часто рассматривается опера-

ция изменения базиса путем замены в нем одного вектора.

Пусть имеется множество базисных векторов аь ..., аг для Еп

г

и какой-нибудь другой вектор d=£0. Тогда d=2a.a/. Если

/==1 7

один из векторов а7, для которого aj=A0, удалить из базиса и

вместо него ввести вектор d, то новое множество из г векторов

также будет базисом для Еп {ЛА 2.9}. Если х — произвольный

3*

36 Гл. 2. Необходимый математический аппарат

вектор из £п, х = 2 ^уау» то после замены а& на d мы, разрешив

Г / = 1

уравнение d=2aJaJ относительно и подставив результат в

г ;=i

*Х= 2 получим

а/

«Л

— d.

(2.6)

Если d замещает вектор а;, для которого aj = 0, то новое множе-

ство векторов оказывается линейно зависимым и, следовательно,

не может быть базисом.

Любой базис пространства Еп содержит в точности п векто-

ров; любые п линейно независимых векторов из Еп составляют

базис Еп. Отсюда следует, что любые п+1 векторов из Еп ли-

нейно зависимы. При т<п любые m линейно независимых век-

торов образуют часть базиса пространства Еп. Таким образом,

существует бесконечное число базисов для Еп. Доказательство

всех этих фактов можно найти в {ЛА 2.10}.

Подпространством S пространства Еп называется множество

векторов из Еп', замкнутое относительно операций сложения и

умножения на скаляр. Размерность подпространства опреде-

ляется как максимальное число линейно независимых векторов

в этом подпространстве. Любое подпространство должно содер-

жать начало координат, так как подпространство замкнуто от-

носительно умножения на скаляр. Таким образом, подпростран-

ство пространства Еп представляет собой евклидово простран-

ство, размерность которого меньше или равна п. Подпростран-

ствами пространства £3, например, являются начало координат

(размерность 0), прямые, проходящие через начало координат,

плоскости, проходящие через начало координат, и само Е3. Мно-

жество всех линейных комбинаций из пг векторов простран-

ства Еп является подпространством пространства Еп {ЛА 2.13}.

Если даны два подпространства Si и S2 пространства Еп, то

совокупность всех векторов вида u + v, где и принадлежит Sb

a v — S2, называется суммой этих подпространств и обозна-

чается Si + S2. Множество St + S2 также является подпростран-

ством, и если 0 — единственный вектор, принадлежащий одно-

временно как Si, так и S2, то размерность Si + S2 равна сумме

размерностей Si и S2. Если S является подпространством Еп,

то ортогональным дополнением к S называется подпростран-

ство O(S), каждый из векторов которого ортогонален всем век-

торам из S. Размерность суммы S + O(S) равна п, т. е.

S + O(S)=En. Любой вектор х из Еп единственным образом

2.1. Матрицы и векторы

37

может быть представлен в виде x = u + v, где и принадлежит S,

av-O(S).

Максимальное число линейно независимых столбцов в матри-

це А называется рангом матрицы А. Максимальное число ли-

нейно независимых строк в А равно максимальному числу ли-

нейно независимых столбцов, и поэтому ранг матрицы А может

быть также определен как максимальное число линейно неза-

висимых строк матрицы А. Ранг матрицы А мы будем обозна-

чать через г (А). Ранг произведения АВ не определяется един-

ственным образом рангами сомножителей А и В, однако

r(AB)<min[r(A), г(В)], {ЛА 4.3}.

Говорят, что квадратная матрица А имеет обратную матрицу,

если существует такая матрица В, что ВА = АВ = 1. Для того

чтобы матрица А порядка п имела обратную матрицу, необхо-

димо и достаточно, чтобы г (А) =п. Если г (А) то матрица А

называется неособенной. Для того чтобы квадратная матрица

была неособенной, необходимо и достаточно, чтобы ее опреде-

литель |А| был отличен от 0. Столбцы неособенной матрицы

образуют базис пространства Еп. То же верно и для строк не-

особенной матрицы. Если для матрицы А не существует обрат-

ной, то она называется особенной. Матрица, обратная для

матрицы А, обычно обозначается через А-1. Обратная матрица

единственна {ЛА 3.18}. Если А и В — неособенные матрицы по-

рядка п, то матрица АВ также неособенная и (АВ)-1 = В_1А-1

{ЛА 3.19}. Верны также соотношения (А-1)-1 = А и (А')-1= (А-1)'.

Если А — неособенная матрица, то г(АВ) =г(В).

Пусть B=(bi, ..., Ьп)—неособенная матрица. Рассмотрим

матрицу Ва, которая получается из матрицы В заменой столб-

ца Ьг на вектор а. Если существует матрица В« \ то она может

быть найдена с помощью матрицы В-1 следующим образом.

Обозначим у = В-1а и

_ Г __У г-i 1 Уг+i __ Уп. 1

1 L У Г. 1 ’ Уг ' Уг' Уг ' " ' ' Ут J *

Затем, построим матрицу Е, заменив в 1л г-й столбец на я.

Тогда Вд1 —ЕВ’1. Для того чтобы матрица В^1 существовала,

необходимо и достаточно, чтобы //г=#0 {ЛА 3.21}.

Если неособенная матрица М может быть представлена

в виде

₽

6 ’

а

V

где 6—неособенная матрица, то

ГА

С

м =

м-1 =

в

D ’

38 Гл. 2. Необходимый математический аппарат

причем {ЛА 3.20}

А = (а —р6~‘у)Л В = —А06"1,

. I, (2.7)

С = — 6-1уА, D = 6-1 —6"\В.

2.2. Системы линейных уравнений. Система m линейных

уравнений с п неизвестными Xj, j=\, п, может быть

п

записана в виде Ах = Ь или —* = 1, •••, w- Такая

7 = 1

система может: а) не иметь решения, Ь) иметь единственное

решение либо с) иметь бесконечное множество решений.

Рассмотрим матрицу АЬ = (А, Ь), называемую расширенной

матрицей данной системы. Возможны два случая: либо г(А&)—

= г(А), либо г(А^)>г(А). Если г(А^) = г(А) = Л, то суще-

ствует k линейно независимых столбцов матрицы А, таких,

что каждый столбец матрицы А*, в частности столбец Ь,

может быть представлен как линейная комбинация этих k

столбцов. Поэтому в этом случае система Ах = Ь имеет по

крайней мере одно решение. С другой стороны, если г(А*)>

>г(А) и r(Aft) = &, то любое множество, состоящее из k

линейно независимых столбцов матрицы Aft, должно содержать

столбец b и, следовательно, столбец b не может быть пред-

ставлен в виде линейной комбинации столбцов матрицы А.

В этом случае система Ах = Ь не имеет решения.

Если для системы Ах=Ь пг уравнений с п неизвестными мы

имеем г(А) =г(А&) =6<п, то существует бесконечное число ре-

шений системы, таких, что n — k переменных могут принимать

произвольные значения. Если г(А) =г(Аь) =п, то система имеет

единственное решение. Если r(A) =r(A&) = k<m, то m — k урав-

нений системы является следствием остальных. Это означает,

что любой вектор х, удовлетворяющий k уравнениям, которым

соответствуют линейно независимые строки в матрице А, удо-

влетворяет всем m уравнениям системы. Для того чтобы полу-

чить все возможные решения, выберем из А неособенную под-

матрицу порядка k. Если k<m, то в исходной системе отбросим

все уравнения, которым в матрице А соответствуют строки, не

вошедшие в выбранную подматрицу. Если n — k переменным,

которые соответствуют столбцам матрицы А, не вошедшим в

подматрицу £-го порядка, придать произвольные значения, то

значения тех k переменных, которые соответствуют столбцам

матрицы А, вошедшим в подматрицу й-го порядка, могут быть

найдены единственным образом, так как эта подматрица неосо-

% бенная. Так мы получим решение системы Ах = Ь. Если указан-

2.2. Системы линейных уравнений

39

ным выше п — k переменным 'позволить пробегать -все возможные

значения, то тогда можно получить все решения системы.

Система уравнений называется однородной, если Ь = 0. Мно-

жество решений системы Ах = 0 представляет собой подпро-

странство пространства Еп размерности п— k, где &==г(А).

(Доказательства, относящиеся к материалу этого параграфа,

даны в {ЛА 5.5} и {ЛА 5.6}.) Заметим, что х=0 всегда является

решением системы Ах=0; х = 0 называется тривиальным реше-

нием. Для того чтобы существовали нетривиальные решения,

необходимо и достаточно, чтобы г(А)<и, где п— число пере-

менных в системе.

Рассмотрим систему m уравнений с п неизвестными, для ко-

торой г(А) =г(А&) = т. Из матрицы А выберем подматрицу по-

рядка т; обозначим ее через В. Пусть хв— вектор, содержащий

переменные, соответствующие столбцам матрицы В. Через' xR

обозначим вектор, содержащий остальные переменные, а че-

рез R — матрицу, состоящую из соответствующих этим перемен-

ным столбцов матрицы А. Для произвольного хв решение си-

стемы можно получить, если положить хв = В-1Ь — В-1 RxB.- Реше-

ние хв = 0, хв = В~1Ь называется базисным решением. Базисное ре-

шение содержит не более чем т отличных от нуля переменных.

Переменные, вошедшие в хв, называются базисными перемен-

ными; остальные переменные называются небазисными. По

определению небазисные переменные равны нулю. Базисное ре-

шение называется вырожденным, если одна или более базисных

переменных равны нулю. Максимальное число возможных ба-

зисных решений для системы Ах = Ь равно n!/m!(n —т)! Это со-

ответствует числу различных комбинаций из т столбцов мат-

рицы А, которые могут быть выбраны для получения подмат-

рицы В. Однако для некоторых таких комбинаций базисное

решение может не существовать, так как входящие в нее век-

торы могут оказаться линейно зависимыми.

Если А — матрица с размерами тХп и х — некоторая точка

из Еп, то у = Ах можно рассматривать как точку из Ет. Для

каждой точки из Еп таким образом определяется единственная

точка у = Ах из Ет. Точка у называется образом х. Говорят, что

матрица А отображает Еп в Ет (или в часть Ет). Совокупность

точек у, которые можно получить, когда х пробегает все Еп,

представляет собой подпространство пространства Ет {ЛА 4.2}.

Таким образом, матрица А отображает (или переводит) Еп в

подпространство Ет.

Отображение, определяемое матрицей, часто называют ли-

нейным преобразованием. Оно сохраняет сложение и умножение

на скаляр, т. е. если yi = Axi и у2 = Ах2, то y = A(xi+x2) =yi+y2.

Аналогично если у=Ах, то Ау является образом Хх.

40

Гл. 2. Необходимый математический аппарат

2.3. Линейное программирование. Общая задача линейного

программирования состоит в том, чтобы найти неотрицательные

значения п переменных xj, удовлетворяющие m линейным огра-

п

ничениям dijXj =, ^}bi> i=\, ..., m, и максимизирую-

щие или минимизирующие линейную целевую функцию

z = 2 с]хг

В этом параграфе мы рассмотрим симплекс-метод для чис-

ленного решения задач линейного программирования. В этом

методе требуется, чтобы все Ь^О. Можно считать, что это усло-

вие выполняется, поскольку если в исходной формулировке за-

дачи какое-либо 6г<0, то мы умножим соответствующее огра-

ничение на —1 (если ограничение было неравенством, то при

этом знак неравенства изменится на противоположный). Если

все то первый шаг состоит в том, чтобы от заданных огра-

ничений перейти к системе линейных уравнений. Это легко мо-

жет быть сделано путем введения дополнительных переменных

{ЛП 3.2}. Предположим, что все ограничения занумерованы та-

ким образом, что первыми оказались ограничения со знаком

неравенства вторыми — ограничения со знаком неравен-

ства <и третьими — равенства. Если ограничение i имеет вид

У а^Х] < bi, то мы введем новую вспомогательную перемен-

i

ную x-n+i, полагая

п п

Xn+i = bi — ^ai)xj, т. е. ^ачх}-\-хп+1 = Ь1. (2.8)

н 7 /=1

Для любых значений переменных Xj, / = 1, .и, удовлетворяю-

щих исходному ограничению, xn+i>0. Если ограничение i имеет

вид ^aijX^bi, то мы введем новую вспомогательную пере-

j

менную %п+г следующим образом:

п п

хп+1=Ъачх} — Ь1, т. е. ^ачх) — хп+1 = Ь1. (2.9)

И здесь при любых xj, удовлетворяющих исходному ограниче-

нию, xn+i>0. Таким образом, от данных ограничений мы пере-

шли к системе m линейных уравнений с N неизвестными: Ах = Ь;

при этом n^N^n + m. Число вновь введенных переменных

равно N—n. Столбцы матрицы А называются производствен-

ными векторами. Производственный вектор, соответствующий

вспомогательной переменной, равен либо единичному вектору,

либо единичному вектору, умноженному на (—1). Между не-

отрицательными векторами, удовлетворяющими исходным огра-

2.3. Линейное программирование

4J

ничениям, и неотрицательными решениями системы Ах = Ь суще-

ствует взаимно однозначное соответствие. Таким образом,

добавлением вспомогательных переменных любую задачу линей-

ного программирования можно свести к следующей эквивалент-

ной задаче: найти max или minz=cx, где с= (сь . ..,Су),при

условиях Ах=Ь и хХ). Это стандартная форма задачи, исполь-

зуемая в симплекс-методе. В дальнейшем число переменных в

задаче линейного программирования мы всегда будем обозна-

чать через п независимо от того, содержат ограничения задачи

неравенства или нет. Любой вектор х, удовлетворяющий усло-

виям Ах = Ь, хХ), будем называть допустимым решением.

Понятно, что описанный только что прием применим и в слу-

чае нелинейной целевой функции, так что задача вида (1.6) —

(1.9) с линейными ограничениями и нелинейной целевой функ-

цией равносильна следующей:

Ах = Ь, х>^0; найти шах или min z — f (хр ..хп\ (2.10)

Вспомогательные переменные могут быть введены и в ограниче-

ния целочисленных задач программирования. При этом но-

вые переменные, определяемые формулами (2.8) и (2.9), даже

при целочисленных значениях исходных переменных могут ока-

заться нецелочисленными, если ац и bi нецелые. Таким образом,

в общем случае введение вспомогательных переменных преобра-

зует полностью целочисленную задачу в смешанную целочис-

ленно-непрерывную. Следует отметить, что во многих случаях

изменение размерности физических величин задачи и времени

позволяет сделать ее полностью целочисленной.

Но вернемся к симплекс-методу. Будем считать, что за-

дача приведена уже к стандартному виду: Ах = Ь, хХ): найти

maxz = cx (мы рассмотрим лишь задачу максимизации, так как

задача минимизации может быть сведена к ней изменением

знака целевой функции). Тогда (см. {ЛП3.6) — {ЛП3.8}):

а) если задача имеет оптимальное решение, то существует

по крайней мере одно базисное оптимальное решение;

Ь) если имеется допустимое базисное, но не оптимальное ре-

шение, то через конечное число шагов от этого решения, можно

перейти к базисному оптимальному решению или же установить,

что целевая функция неограничена на множестве всех допусти-

мых решений, т. е. что существуют допустимые решения, кото-

рым соответствуют сколь угодно большие значения целевой

функции; при этом на каждом шаге осуществляется замена

только одной базисной переменной.

Предположим, что г(А) =г(Аь) =т. (Мы увидим, что это

предположение не исключает вырожденности.) В этом случае

любое базисное допустимое решение содержит не более чем m

42 Г л. 2. Необходимый математический аппарат

положительных переменных. Пусть В — матрица, состоящая из

m линейно независимых столбцов матрицы А. Соответствующее

базисное (не обязательно допустимое) решение может быть за-

писано в виде хв = в-»ь, где все небазисные переменные равны

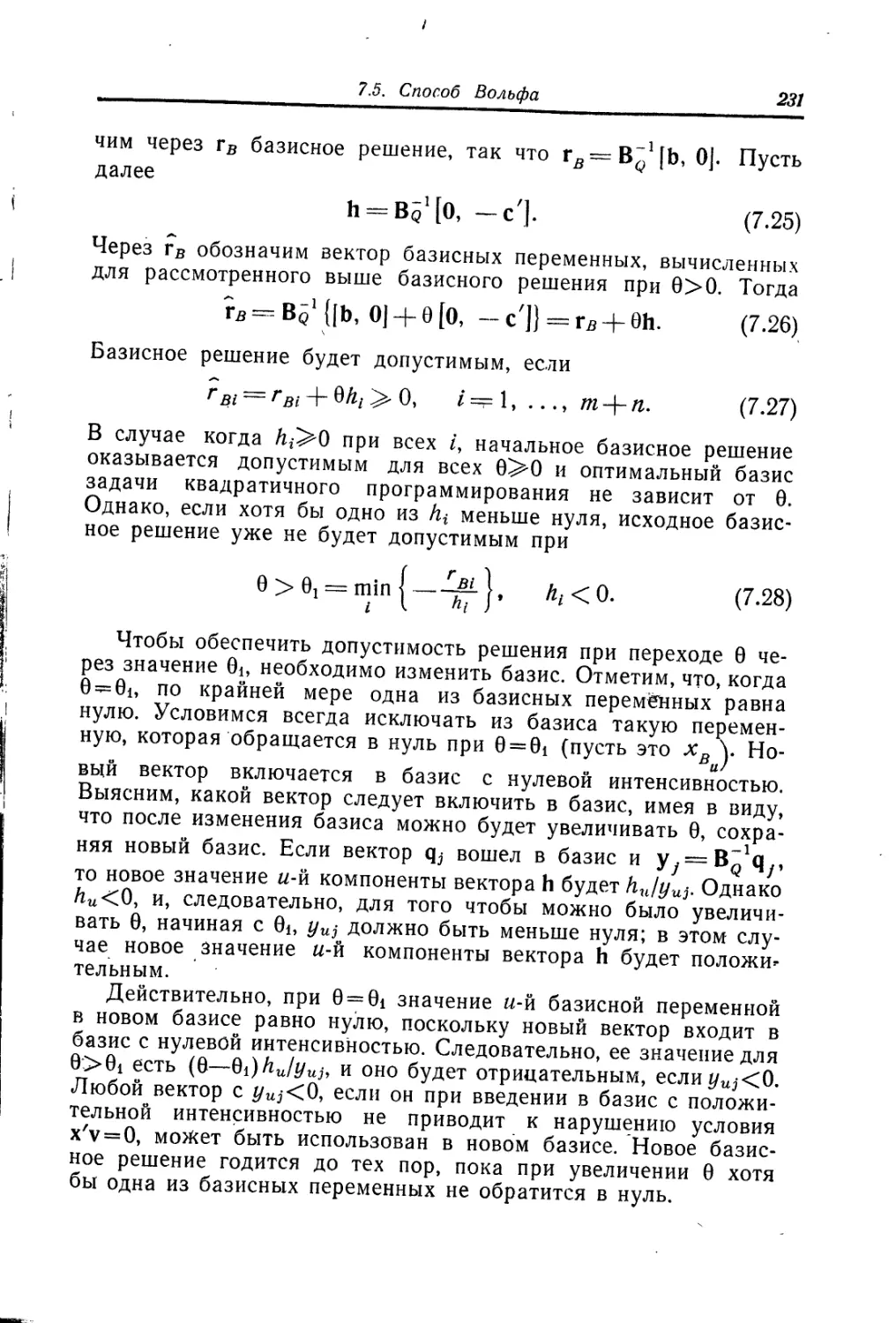

нулю. Значение целевой функции для этого решения равнб