Текст

От издателей русского перевода

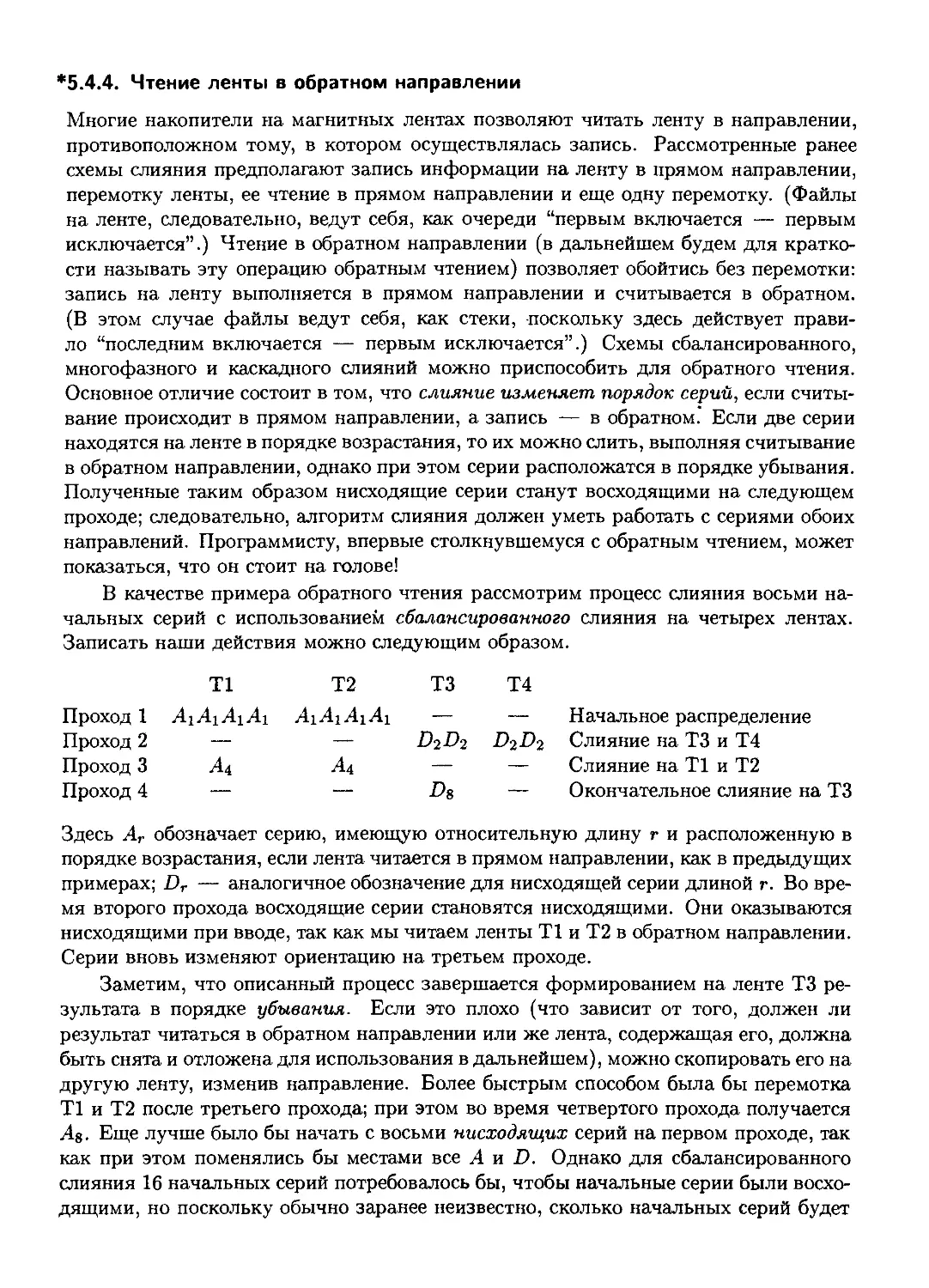

На мировом рынке компьютерной литературы существует множество книг, пред-

предназначенных для обучения основным алгоритмам и используемых при программиро-

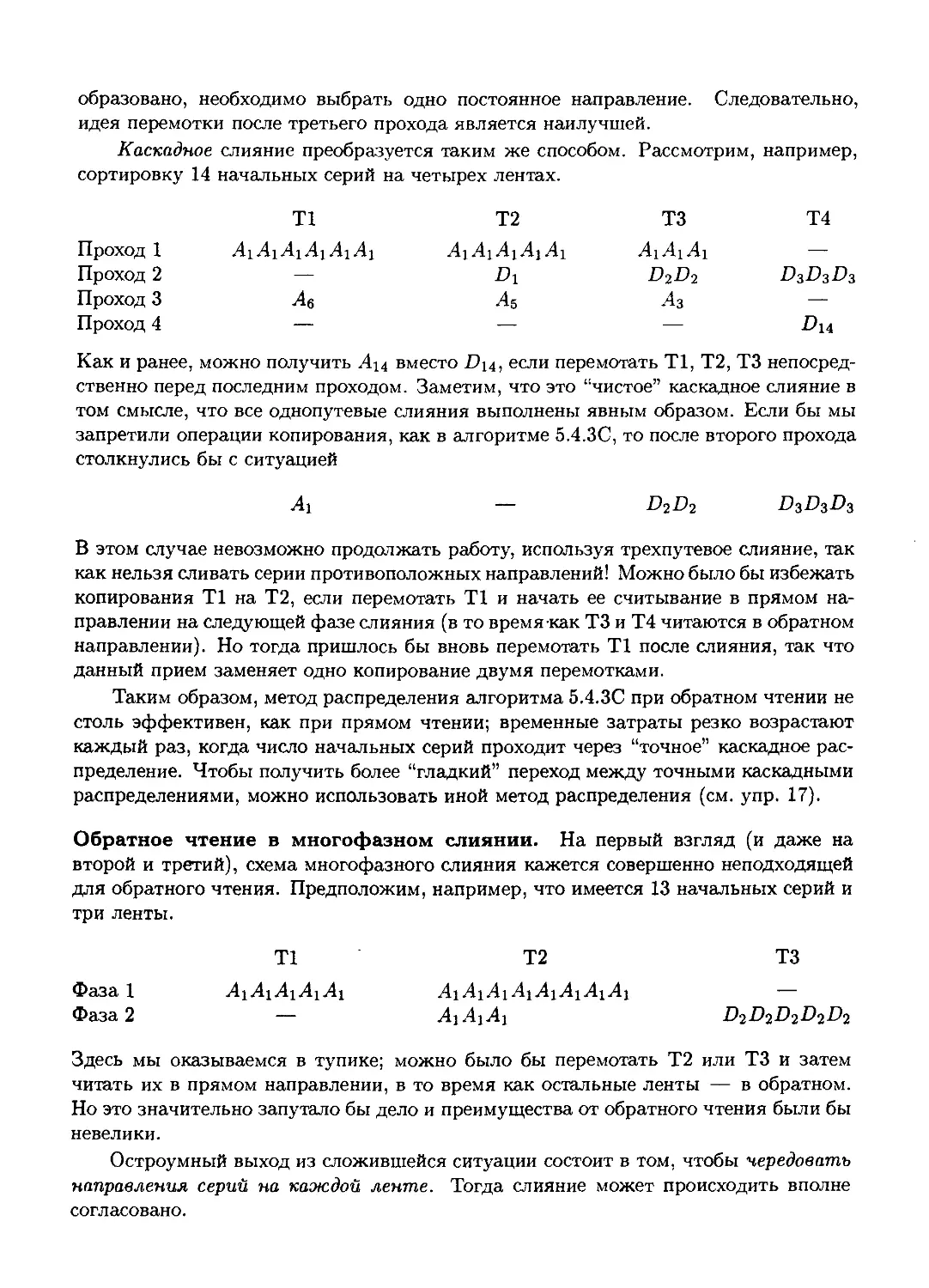

программировании. Их довольно много, и они в значительной степени конкурируют между собой.

Однако среди них есть особая книга. Это трехтомник "Искусство программирования"

Д. Э. Кнута, который стоит вне всякой конкуренции, входит в золотой фонд мировой

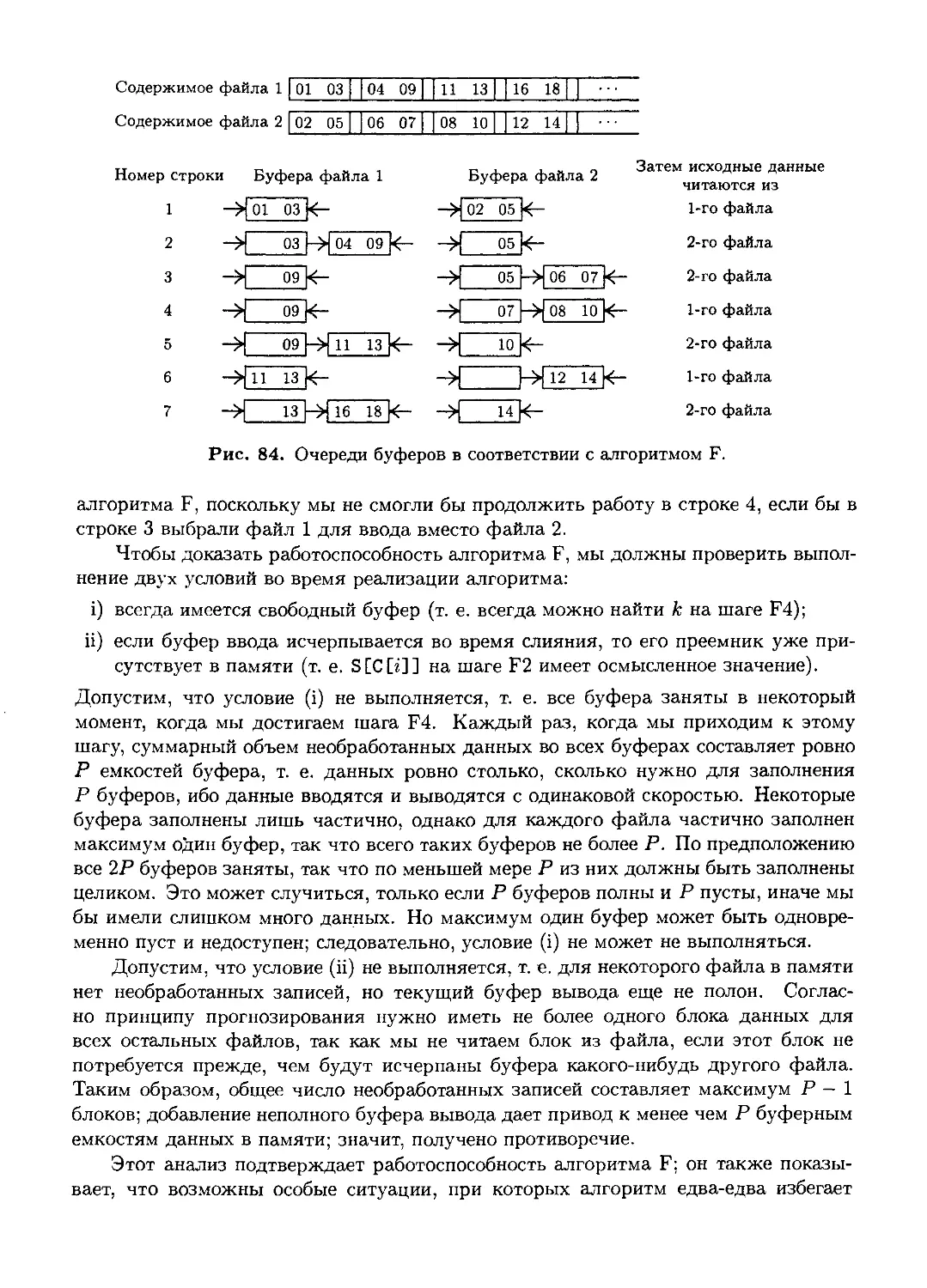

литературы по информатике и является настольной книгой практически для всех, кто

связан с программированием.

Мы как издатели видим ценность книги в том, что она предназначена не столько для

обучения технике программирования, сколько для обучения, если это возможно, "искус-

"искусству" программирования, предлагает массу рецептов усовершенствования программ и,

что самое главное, учит самостоятельно находить эти рецепты.

Ни для кого не секрет, что наши программисты являются одними из наиболее вы-

высококвалифицированных специалистов в мире. Они достойно представляют за рубежом

отечественную школу программирования и информатики, которая внесла значительный

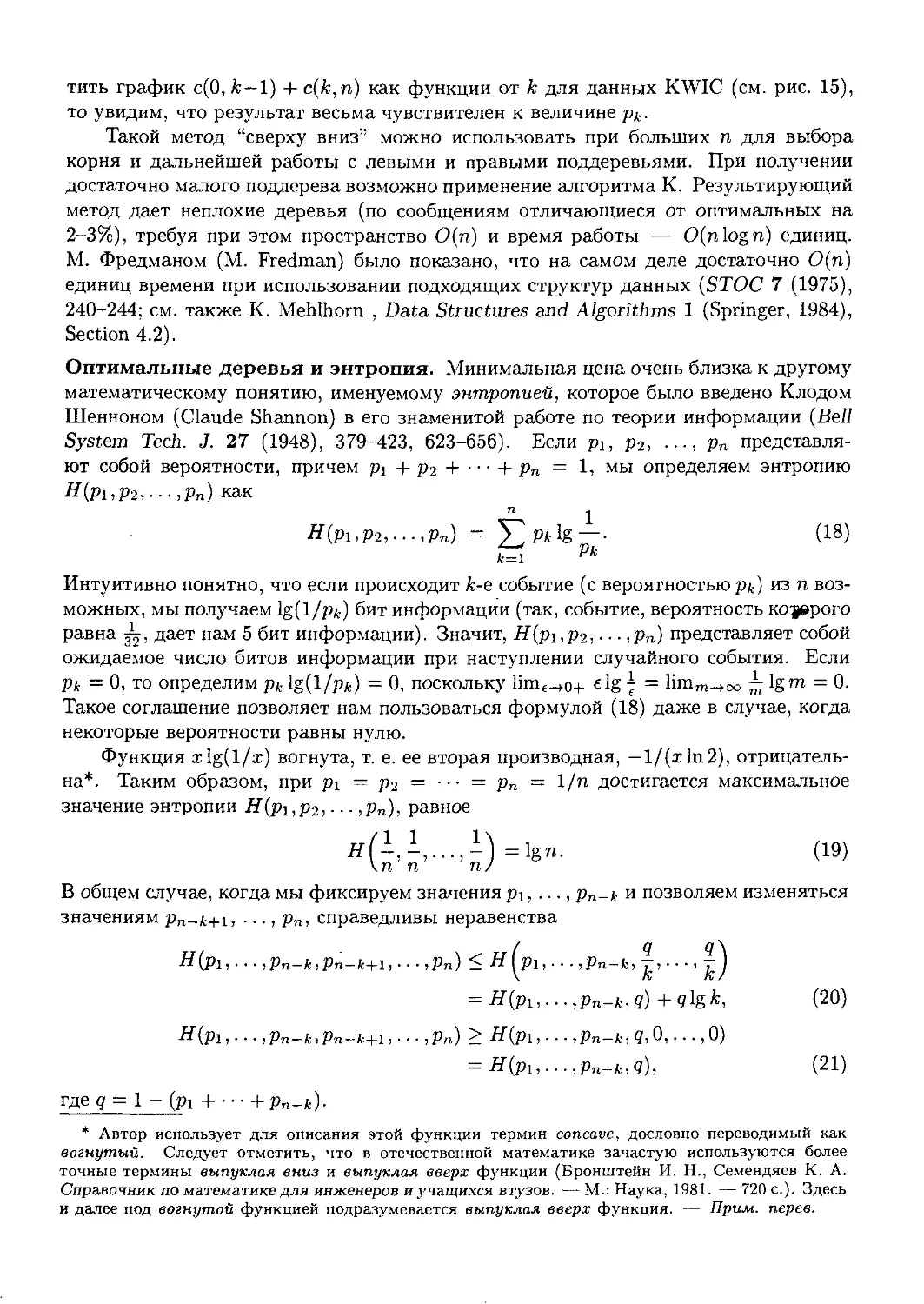

вклад в формирование фундаментальных основ компьютерных наук. Для сохранения

такого уровня и продвижения вперед необходимо своевременное издание на русском

языке книг, отражающих основные мировые достижения в этой области. Трехтомник

"Искусство программирования" Д. Э. Кнута — одна из таких книг.

Мы гордимся тем, что библиотеки программистов, преподавателей, студентов, стар-

старшеклассников и многих других пополнятся этой классической книгой и что тем самым

мы внесем свой вклад в формирование более глубокого понимания основ компьютерных

наук. Мы глубоко убеждены, что книга "Искусство программирования" Д. Э. Кнута

способна приблизить человека к совершенству. Надеемся, наше издание на русском

языке этой замечательной книги еще раз подтвердит, что истинные ценности с годами

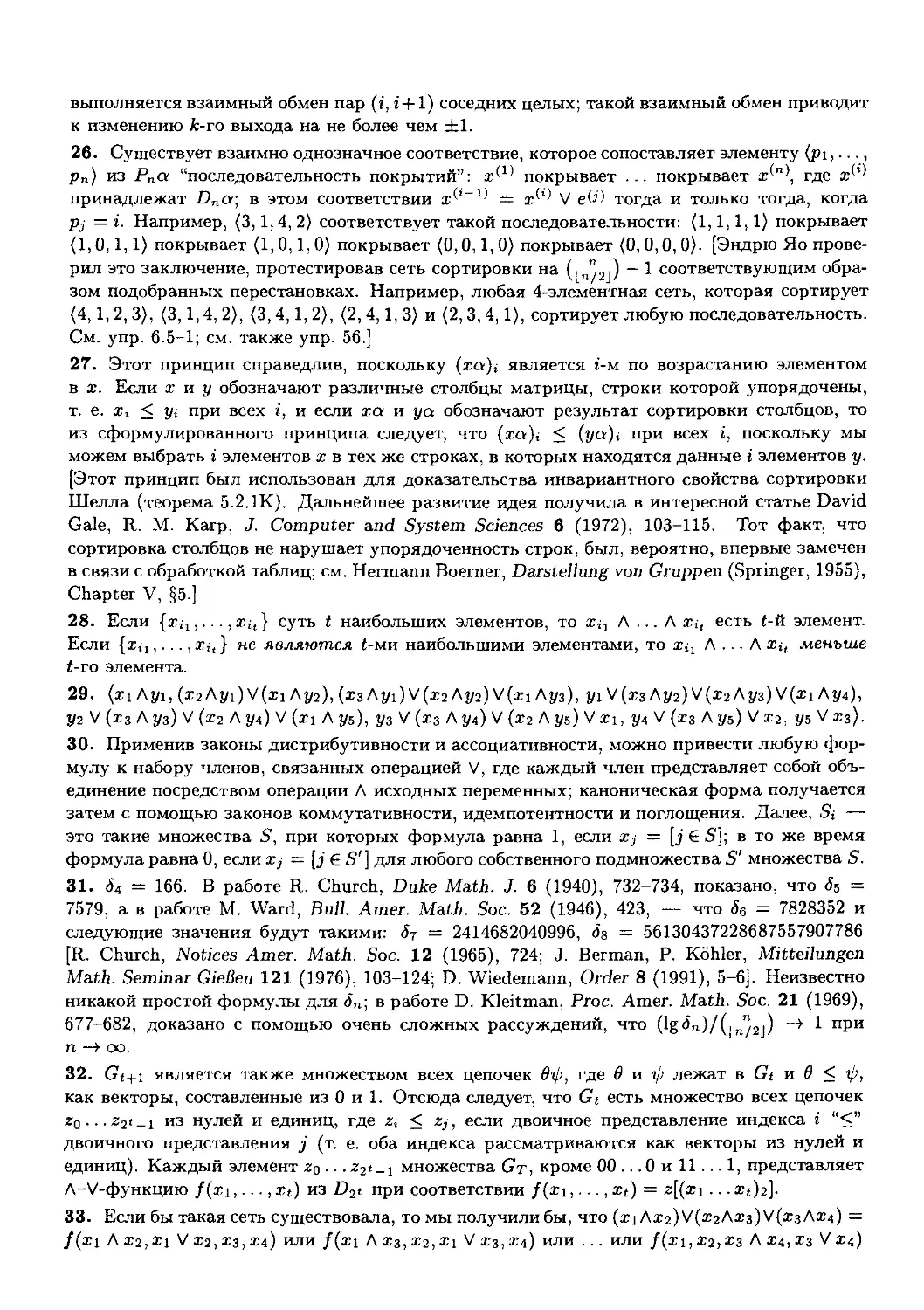

не устаревают.

— Виктор Штонда, Геннадий Петриковец, Алексей Орлович,

издатели

О книге "Искусство программирования'

У каждой книги своя судьба. Одни появляются незаметно и так же незаметно исче-

исчезают в потоке времени, покрываясь пылью на полках библиотек. Другие в определенный

период пользуются спросом у узкого круга специалистов, пока им на смену не приходят

новые справочники. Третьи, поднимаясь над временем, оказывают мощное влияние

на технологическое развитие общества. Книг, относящихся к последней категории, не

так уж и много. Их выход в свет — всегда праздник. Проходят годы, изменяются

технологии, но новые поколения с постоянным интересом перечитывают их страницы.

Именно к таким книгам относится предлагаемый читателю многотомный труд известного

американского ученого Дональда Эрвина Кнута "Искусство программирования"

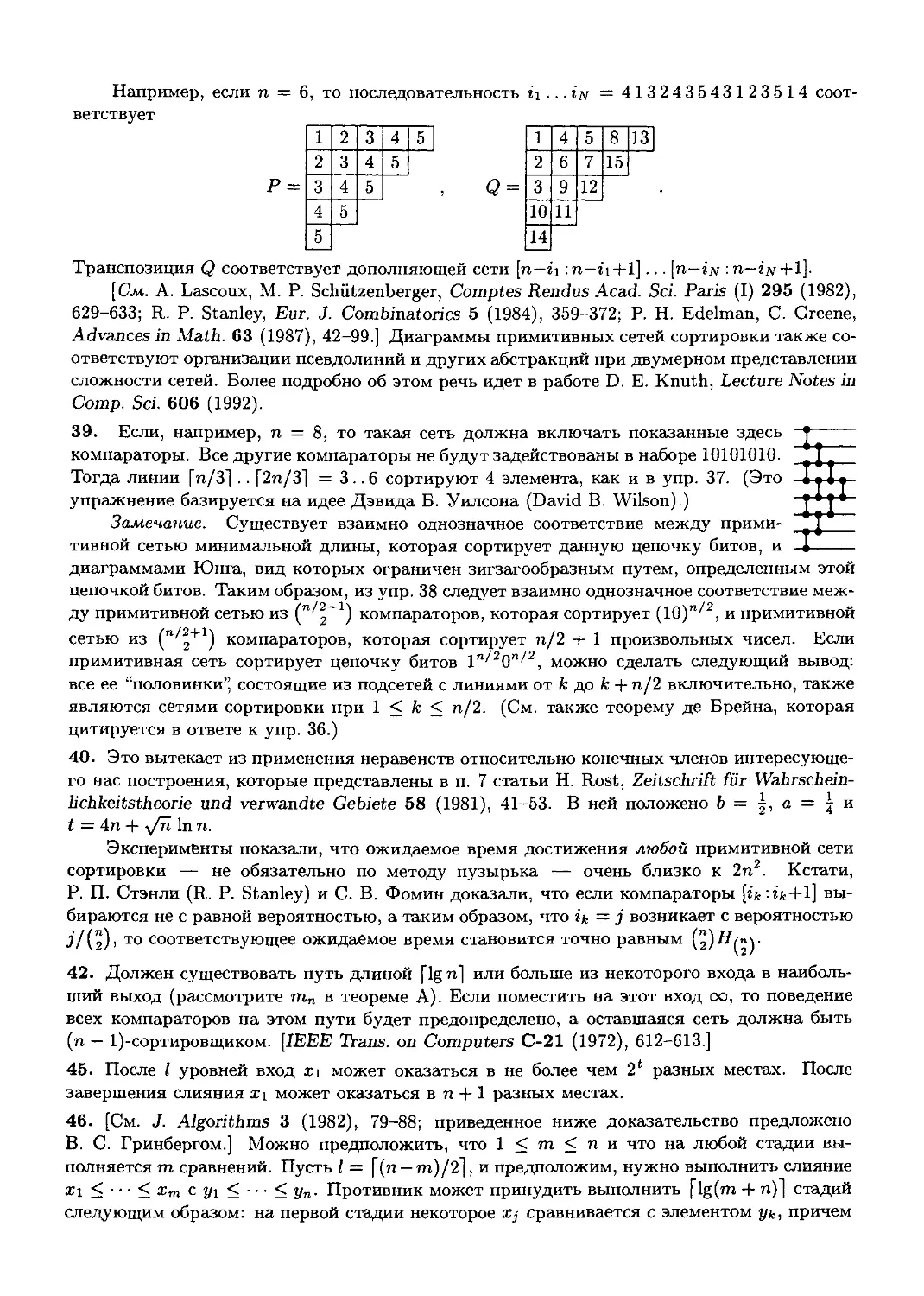

Прошло почти 30 лет со времени первого издания в 1972 году в США этой кни-

книги. Она была переведена на большинство языков мира, в том числе и на русский.

К настоящему времени на территории стран СНГ трехтомник Д. Э. Кнута стал би-

библиографической редкостью. В 1998 году в США вышло третье издание "Искусства

программирования" В нем сохранена последовательность изложения материала преж-

прежних версий, но значительно расширен список ссылок, в который включены свежие и

наиболее важные результаты, добавлены новые упражнения и комментарии, устранены

неточности. Учитывая популярность во всем мире "Искусства программирования" дав-

давно следовало ожидать появления нового переводного издания на русском языке, которое

вы и держите в руках.

В чем же успех "Искусства программирования" Д. Э. Кнута?

Во-первых, эта книга — великолепное учебное пособие по составлению и анали-

анализу компьютерных алгоритмов. Ее разделы могут быть включены во многие универ-

университетские курсы по технологиям программирования, теории алгоритмов, дискретной

математике. Книгу могут изучать и школьники старших классов, знакомые с основами

программирования. В качестве основного языка записи алгоритмов автор выбрал язык

машинных команд гипотетического универсального компьютера MIX. Это позволяет

строить оптимальные программы с учетом особенностей вычислительных машин. Пере-

Перенести Mix-программы на реальные ЭВМ или переписать их на языках высокого уровня не

составляет особого труда. Логика работы программ почти всегда поясняется простыми

блок-схемами.

Во-вторых, тщательно подобранный материал, вошедший в книгу, включает в себя

основные фундаментальные классы алгоритмов, которые в том или ином виде наиболее

часто встречаются в практике программирования.

В-третьих, немаловажным фактором успеха книги Д. Э. Кнута является энциклопе-

дичность изложения. Профессор Кнут отличается уникальной способностью отслежи-

отслеживать проблему от исторических предпосылок ее зарождения до современного состояния.

Многочисленные ссылки на работы старых мастеров (вплоть до времен античности),

заключенные в современный контекст, создают у читателя особое чувство причастности

к историческому развитию научных идей и методов.

В-четвертых, следует отметить мастерство изложения. Книга рассчитана на ши-

широкий круг читателей — от начинающих студентов до программистов-профессионалов.

Каждому будет интересно изучать компьютерные алгоритмы на своем уровне. Материал

самодостаточен. Для понимания сути методов не требуется знания особых разделов

математики или специальных технологий программирования. Прослеживается опреде-

определенная "музыкальная" композиция сюжетного построения (дома у Д. Э. Кнута есть

небольшой орган, на котором он играет).

Список составляющих успеха "Искусства программирования" можно легко про-

продолжить.

Автор этих строк прослушал курс "Искусство программирования" в изложении про-

профессора Кнута в 1976-1977 годах во время стажировки в Станфордском университете.

Тогда формировалась алгоритмическая основа технологий программирования, у истоков

которой стоял Д. Э. Кнут. Было много обсуждений, семинаров, творческих замыслов.

Значительные книги всегда связаны с судьбой автора. Дональд Эрвин Кнут начал

работу над "Искусством программирования" в 1962 году. Продолжает ее и сейчас. У

него много планов. Впереди новые тома "Искусства программирования" которых с

нетерпением ждут читатели.

— Профессор Анатолий Анисимов

От редактора перевода

Со времени первого издания книги "Искусство программирования" Д. Э. Кнута

прошло около 25 лет. Тем не менее книга не только не устарела, но по-прежнему остается

основным руководством по искусству программирования, книгой, по которой учатся

понимать суть и особенности этого искусства.

За эти годы на английском языке вышло уже третье издание 1-го и 2-го томов, а

также второе издание 3-го тома. Автор внес в них значительные изменения и существен-

существенные дополнения. Достаточно сказать, что число упражнений практически удвоилось,

а многие упражнения, включенные в предыдущие издания (особенно ответы к ним),

модифицированы. Существенно дополнены и переделаны многие главы и разделы,

исправлены неточности и опечатки, добавлены многочисленные новые ссылки на ли-

литературу, использованы теоретические результаты последних лет.

Значительно преобразилась глава 3, особенно разделы 3.5 и 3.6, а также разделы

4.5.2, 4.7, 5.1.4, 5.3, 5.4.9, 6.2.2, 6.4, 6.5 и др.

Естественно, возникла необходимость в новом издании книги.

Перевод выполнен по третьему изданию 1-го и 2-го томов и второму изданию 3-го

тома. Кроме того, учтены дополнения и исправления, любезно предоставленные авто-

автором.

При переводе мы старались сохранить стиль автора, обозначения и манеру изложе-

изложения материала. В большинстве случаев использовались термины, принятые в научной

литературе на русском языке. При необходимости приводились английские эквивален-

эквиваленты. По многим причинам, в частности из-за сложности некоторых разделов, читать

книгу "Искусство программирования" далеко непросто. Одной из причин, которые

затрудняют понимание книги, является манера изложения автора; привыкнув к ней,

можно существенно облегчить чтение.

Из-за обилия материала (часто мало связанного между собой) невозможно постро-

построить книгу так, чтобы различные понятия и определения вводились сразу же при первом

упоминании о них. Поэтому в главе 1 могут обсуждаться без ссылок понятия, строгие

определения которых приводятся в 3-м томе. Именно поэтому так велика роль пред-

предметного указателя, без которого понимание книги было бы существенно затруднено.

Надеемся, что читатель не будет удивлен, найдя ссылки на главы 7, 8 и последующие

не вошедшие в предлагаемые три тома главы. Мы вместе с автором надеемся, что очень

скоро они будут опубликованы и, безусловно, сразу же появятся в русском переводе в

качестве продолжения этого издания.

Следует также обратить внимание на далеко не всегда стандартные обозначения, ко-

которыми пользуется автор. Так же, как и определения, эти обозначения могут появиться

в 1-м томе, а вводится во 2-м. Поэтому без указателя обозначений пользоваться книгой

было бы чрезвычайно трудно. Хочу также обратить внимание на запись [А], где А —

некоторое высказывание. Эта запись встречается в формулах, а иногда и в тексте, и

обозначает величину, равную индикатору А.

— Профессор Ю. В. Козаченко

ПРЕДИСЛОВИЕ

Кулинария — это искусство, благородная наука;

все кулинары — джентльмены.

— ТИТ ЛИВИИ, АЬ Urbe Condita XXXIX.vi

(ROBERT BURTON, Anatomy of Melancholy 1.2.2.2)

Настоящий том является логическим продолжением материала об информаци-

информационных структурах, содержащегося в главе 2 тома 1, так как в нем к основным

структурным идеям добавляется понятие линейно упорядоченных данных.

Название "Сортировка и поиск" может ввести читателя в заблуждение, и он

решит, что эта книга предназначена только для тех системных программистов,

которые занимаются подготовкой программ сортировки общего назначения или при-

приложений, выполняющих выборку информации. Но на самом деле тема сортировки

и поиска представляет собой идеальную основу для обсуждения широкого круга

важных общих вопросов.

• Насколько хороши разработанные алгоритмы?

• Как улучшить имеющиеся алгоритмы и программы?

• Как с помощью математических методов проанализировать эффективность ал-

алгоритмов?

• Как правильно выбрать алгоритм для решения поставленной задачи?

• В каком смысле алгоритм можно считать наилучшим из возможных?

• Какое влияние друг на друга оказывают теория и практика вычислений?

• Как эффективно использовать для больших баз данных внешние носители ин-

информации, такие как магнитные ленты, барабаны и диски?

На самом деле я считаю, что практически каждый важный аспект программирова-

программирования возникает в связи с сортировкой и поиском!

В данный том входят главы 5 и 6. Глава 5 посвящена сортировке в определенном

порядке. Эта большая тема разделена на две основные части, в которых речь идет

о внутренней и внешней сортировке. В главу 5 включены также дополнительные

разделы. В них излагаются вспомогательные теории подстановок (раздел 5.1) и

оптимальных методов сортировки (раздел 5.3). В главе 6 изучается проблема поиска

определенных элементов в таблицах или файлах. Здесь рассматриваются методы

последовательного поиска, методы сравнения ключей либо цифровых свойств и

хеширования, а также исследуется более сложная проблема — выборка вторичного

ключа. Главы 5 и 6 очень взаимосвязаны между собой; многие их темы аналогичны.

В них обсуждается два различных варианта информационных структур (в дополне-

дополнение к тем, которые рассматривались в главе 2), а именно: очереди с приоритетами

(раздел 5.2.3) и линейные списки, представляемые в качестве сбалансированных

деревьев (раздел 6.2.3).

Как и в тома 1 и 2, в этот том включен большой объем ранее не публиковавше-

публиковавшегося материала. Многие рассказывали или писали мне о своих идеях, и я надеюсь,

что я не слишком исказил их мысли, выразив их собственными словами.

У меня нет времени на систематическое изучение патентоведческой литературы.

Кроме того, я осуждаю нынешнюю тенденцию к получению патентов на алгоритмы

(раздел 5.4.5). Если кто-либо пришлет мне копию соответствующего патента, на

который нет ссылки в данной книге, то я обязательно сделаю такую ссылку в

следующих изданиях. Но все-таки я призываю современных специалистов следовать

многовековой математической традиции — делать вновь найденные алгоритмы

предметом всеобщего достояния. Существуют более достойные способы зарабаты-

зарабатывания на жизнь, чем не давать другим пользоваться своим вкладом в компьютерную

науку.

Еще будучи преподавателем я использовал данную книгу в качестве учебника

для студентов по структурам данных. Я читал этот курс и на младших, и на

старших курсах, опуская большую часть математического материала. В то же

время более сложные математические выкладки я использовал как основу для курса

анализа алгоритмов, который читался на старших курсах университета (главным

образом, это относится к разделам 5.1, 5.2.2 и 6.4). Курс по сложности вычислений

(предназначенный для выпускного курса университета) может быть основан на

разделах 5.3 и 5.4.4, а также 4.3.3, 4.6.3 и 4.6.4 тома 2.

Настоящий том, в основном, представляет собой полную и самостоятельную

книгу; исключением являются лишь разделы, касающиеся компьютера MIX, описа-

описание которого приведено в томе 1. В приложении Б приведены использованные в

данной книге математические обозначения, которые иногда отличаются от приня-

принятых в традиционной математической литературе.

Предисловие ко второму изданию

Это новое издание соответствует третьим изданиям томов 1 и 2. В них я отметил

завершение разработки систем TfrjX и METflFONT тем, что применил их для набора

книг, для которых они были предназначены.

Перейдя к электронной версии книги, я получил возможность проверить каждое

слово и каждый знак пунктуации в тексте. Я старался сохранить юношеский задор

оригинальных предложений и в то же время внести большую зрелость суждений.

Были добавлены десятки новых упражнений, а на десятки старых даны новые или

улучшенные ответы. Изменения коснулись всего текста, но особенно это относится

к разделам 5.1.4 (перестановки и диаграммы), 5.3 (оптимальная сортировка), 5.4.9

(сортировка на диске). 6.2.2 (энтропия), 6.4 (универсальное хеширование) и 6.5

(многомерные деревья).

/^ч. Таким образом, работа над книгой Искусство программирования продолжается.

JL Исследования получисленных алгоритмов продвигаются с феноменальной ско-

ростью. Именно поэтому некоторые разделы данной книги начинаются пиктограм-

пиктограммой "В процессе построения" (это своеобразное извинение за то, что приведены не

самые новые данные). Например, если бы в настоящее время я читал на последнем

курсе университета курс по структурам данных, то я обязательно включил бы

обсуждение случайных структур, таких как рандомизированные бинарные деревья

поиска и другие. Но пока я могу только сослаться на основные статьи по этому

предмету, а также объявить о написании в будущем раздела 6.2.5. Мои шкафы пе-

переполнены важными материалами, которые я планирую включить в окончательное

издание тома 3; оно выйдет, вероятно, через 17 лет. Но сначала я должен закончить

тома 4 и 5. Я хочу, чтобы они были опубликованы сразу же, как только будут

готовы к печати.

Я чрезвычайно благодарен сотням людей, которые помогали мне собирать ма-

материал в течение последних 35 лет. Большая часть тяжелой работы по подготовке

этого нового издания была выполнена Филлис Винклер (Phillis Winkler), которая

перенесла текст первого издания в формат TjjX, Сильвио Леви (Silvio Levy), который

профессионально отредактировал текст и помог подготовить несколько десятков ил-

иллюстраций, а также Джеффри Олдхэмом (Jeffrey Oldham), который конвертировал

свыше 250 оригинальных иллюстраций в формат METflPOST. Большую помощь, как

всегда, оказывали и сотрудники производственного отдела издательства Addison-

Wesley.

Я исправил все ошибки, которые бдительные читатели обнаружили в первом

издании (а также ошибки, которые, увы, не заметил никто), и постарался избежать

появления новых ошибок в новом материале. Тем не менее я допускаю, что некото-

некоторые огрехи все же остались, и хотел бы исправить их как можно скорее. Поэтому за

каждую опечатку* а также ошибку, относящуюся к сути излагаемого материала или

к приведенным историческим сведениям, я охотно заплачу $2,56 тому, кто первым

ее найдет. На Web-странице, адрес которой приведен на обложке книги, содержится

текущий список всех найденных ошибок и их исправлений, о которых мне сообщили.

Станфорд, Калифорния D. Е. К.

Июль 1997

Писатель пользуется известными привилегиями, в пользе которых,

надеюсь, нет никаких оснований сомневаться. Так, встретив

у меня непонятное место, читатель должен предположить,

что под ним кроется нечто весьма полезное и глубокомысленное.

— ДЖОНАТАН СВИФТ, Сказка бочки, предисловие A704)

* Имеется в виду оригинал настоящего издания. — Прим. ред.

ПРИМЕЧАНИЯ К УПРАЖНЕНИЯМ

Упражнения, приведенные в этой серии книг, предназначены как для самостоя-

самостоятельной проработки, так и для семинарских занятий. Очень трудно и, наверное,

просто невозможно выучить предмет, только читая теорию и не применяя ее для

решения конкретных задач, которые заставляют задуматься о прочитанном. Более

того, мы лучше всего заучиваем то, до чего дошли самостоятельно, своим умом.

Поэтому упражнения занимают важное место в данном издании. Я приложил нема-

немало усилий, чтобы сделать их как можно более информативными, а также отобрать

задачи, которые были бы не только поучительны, но и позволяли читателю получить

удовольствие от их решения.

Во многих книгах простые упражнения даются вместе с исключительно слож-

сложными. Это не всегда удобно, так как читателю хочется знать заранее, сколько вре-

времени ему придется затратить на решение задач (иначе в лучшем случае он их только

просмотрит). В качестве классического примера подобной ситуации можно привести

книгу Ричарда Беллмана (Richard Bellman) Динамическое программирование (М.:

Изд-во иностр. лит., 1960). Это очень важная, новаторская работа, но у нее есть

один недостаток: в конце некоторых глав в разделе "Упражнения и научные пробле-

проблемы" среди серьезных, еще нерешенных проблем приводятся простейшие вопросы.

Говорят, что кто-то однажды спросил д-ра Беллмана, как отличить упражнения

от научных проблем, и он ответил: "Если вы можете решить задачу, значит, это

упражнение; в противном случае это научная проблема"

Совершенно очевидно, что в книге, подобной этой, должны быть приведены и

сложные научные проблемы, и простейшие упражнения. Поэтому, чтобы читатель

не ломал голову, пытаясь отличить одно от другого, были введены рейтинги, ко-

которые определяют степень сложности каждого упражнения. Эти рейтинги имеют

следующее значение.

Рейтинг Объяснение

00 Чрезвычайно простое упражнение, на которое можно ответить сразу же,

если прочитанный материал понят. Упражнения подобного типа почти

всегда можно решить "в уме".

10 Простая задача, которая заставляет задуматься над прочитанным, но не

представляет особых трудностей. На ее решение вы затратите не больше

минуты; в процессе решения могут понадобиться карандаш и бумага.

20 Средняя задача, которая позволяет проверить, понял ли читатель основ-

основные положения изложенного материала. Чтобы получить исчерпываю-

исчерпывающий ответ, может понадобиться примерно 15-20 минут.

30 Задача умеренной сложности. Для ее решения может понадобиться более

двух часов (а если одновременно вы смотрите телевизор, то еще больше).

40 Достаточно сложная или трудоемкая задача, которую вполне можно

включить в план семинарских занятий. Предполагается, что студент

должен справиться с ней, затратив не слишком много времени, и решение

будет нетривиальным.

50 Научная проблема, которая (насколько известно автору в момент напи-

написания книги) пока еще не получила удовлетворительного решения, хотя

найти его пытались очень многие. Если вы нашли решение подобной

проблемы, то опубликуйте его; более того, автор данной книги будет

очень признателен, если ему сообщат решение как можно скорее (при

условии, что оно правильно).

Интерполируя по этой "логарифмической" шкале, можно понять, что означает

любой промежуточный рейтинг. Например, рейтинг П говорит о том, что упраж-

упражнение немного проще, чем задача средней сложности. Если задача с рейтингом 50

будет впоследствии решена каким-либо читателем, то в следующих изданиях данной

книги и в списке ошибок, опубликованных в Internet, она может иметь рейтинг 45

(адрес Web-страницы приводится на обложке книги).

Остаток от деления рейтинга на 5 показывает, какой объем рутинной работы

потребуется для решения данной задачи. Таким образом, для выполнения упраж-

упражнения с рейтингом 24 может потребоваться больше времени, чем для упражнения

с рейтингом 25, но для последнего необходим более творческий подход.

Автор очень старался правильно присвоить рейтинги упражнениям, но тому,

кто составляет задачи, трудно предвидеть, насколько сложными они окажутся для

кого-то другого. К тому же одному человеку некая задача может показаться про-

простой, а другому — сложной. Таким образом, определение рейтингов — дело

достаточно субъективное и относительное. Я надеюсь, что рейтинги помогут вам

получить правильное представление о степени трудности задач, но их следует вос-

воспринимать в качестве ориентира, а не в качестве абсолюта.

Эта книга написана для читателей с различным уровнем математической подго-

подготовки и научного кругозора, поэтому некоторые упражнения рассчитаны исключи-

исключительно на тех, кто серьезно интересуется математикой или занимается ею профес-

профессионально. Если рейтингу предшествует буква М, значит, математические понятия

и обоснования используются в упражнении в большей степени, чем это необходи-

необходимо тому, кто интересуется в основном программированием алгоритмов. Если же

упражнение отмечено буквами НМ, то для его решения необходимо знание высшей

математики в большем объеме, чем дается в настоящей книге. Но пометка НМ

совсем необязательно означает, что упражнение трудное.

Перед некоторыми упражнениями стоит стрелка ">", которая означает, что они

особенно поучительны и их очень рекомендуется выполнить. Само собой разумеется,

никто не ожидает, что читатель (или студент) будет решать все задачи, поэтому

наиболее важные из них и были выделены. Но это ни в коем случае не означает,

что другие упражнения выполнять не стоит! Каждый читатель должен хотя бы

попытаться решить все задачи, рейтинг которых меньше или равен 10. Стрелки

помогут выбрать задачи с более высокими рейтингами, которые следует решать в

первую очередь.

К большинству упражнений приведены ответы, помещенные в отдельном раз-

разделе в конце книги. Пожалуйста, пользуйтесь ими разумно: ответ смотрите только

после того, как приложите все усилия, чтобы решить задачу самостоятельно, либо

если у вас совершенно нет времени на ее решение. Ответ будет поучителен и

полезен для вас только в том случае, если вы ознакомитесь с ним после того, как

найдете свое решение или изрядно потрудитесь над задачей. Ответы к задачам

излагаются очень кратко и схематично, так как предполагается, что читатель честно

пытался решить задачу собственными силами. Иногда в приведенном решении

дается меньше информации, чем спрашивалось, но чаще бывает наоборот. Вполне

возможно, что полученный вами ответ окажется лучше того, который помещен

в книге, или вы найдете ошибку в ответе. В таком случае автор был бы очень

признателен, если бы вы как можно скорее подробно сообщили ему об этом; тогда в

последующих изданиях книги будет опубликовано более удачное решение, а также

имя его автора.

Решая задачи, вы, как правило, можете пользоваться ответами к предыдущим

упражнениям, за исключением случаев, когда это будет оговорено особо. Рей-

Рейтинги упражнениям присваивались в расчете именно на это, и вполне возможно,

что рейтинг упражнения п + 1 ниже рейтинга упражнения п, даже если результат

упражнения п является его частным случаем.

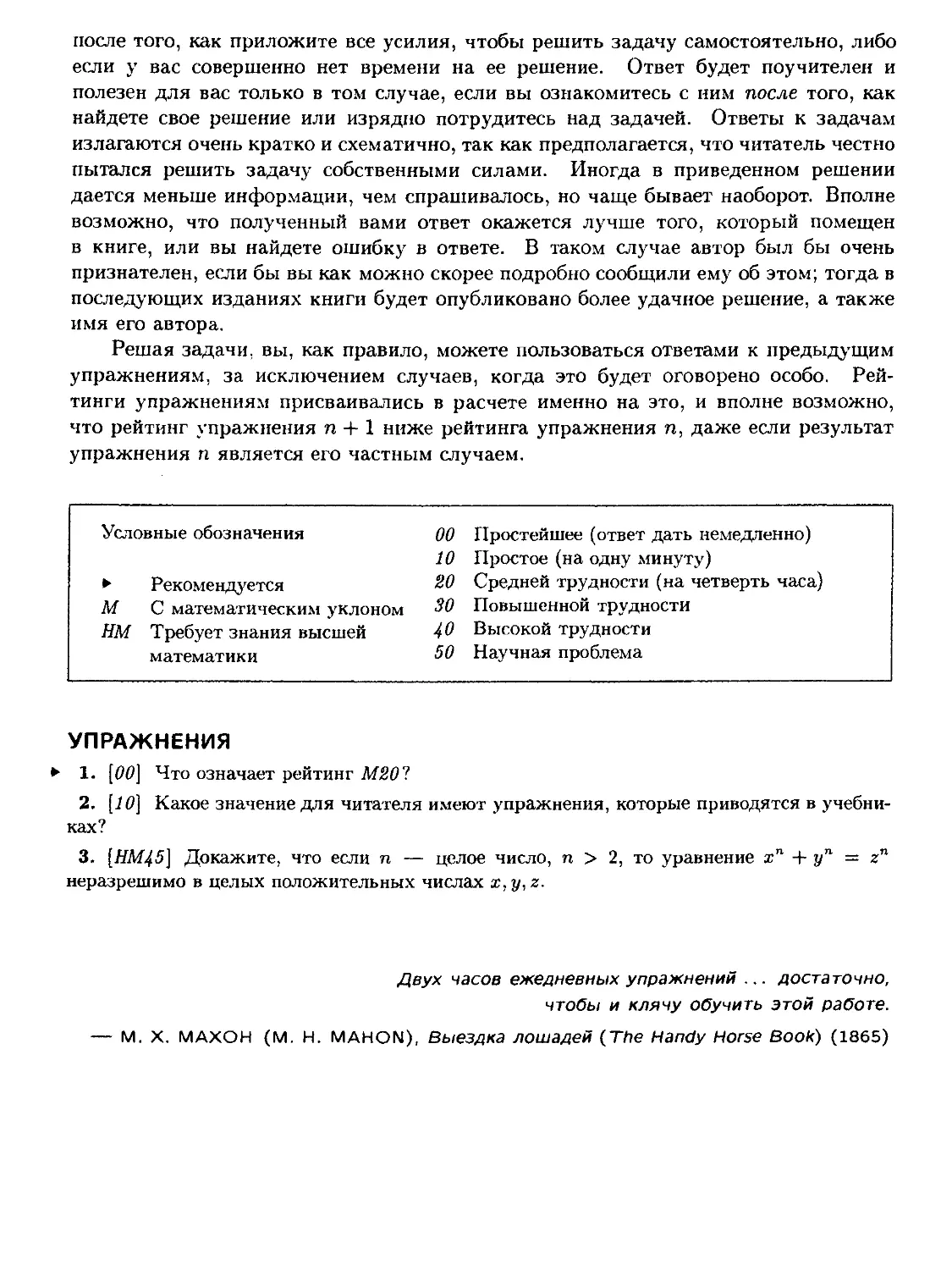

Условные обозначения

М

нм

Рекомендуется

С математическим уклоном

Требует знания высшей

математики

00

10

20

30

40

50

Простейшее (ответ дать немедленно)

Простое (на одну минуту)

Средней трудности (на четверть часа)

Повышенной трудности

Высокой трудности

Научная проблема

УПРАЖНЕНИЯ

> 1. [00] Что означает рейтинг M20f

2. [10] Какое значение для читателя имеют упражнения, которые приводятся в учебни-

учебниках?

3. [НМ45] Докажите, что если п — целое число, п > 2, то уравнение хп + уп = zn

неразрешимо в целых положительных числах х, у, г.

Двух часов ежедневных упражнений ... достаточно,

чтобы и клячу обучить этой работе.

— М. X. МАХОН (М. Н. MAHON), Выездка лошадей (The Handy Horse Book) A865)

ГЛАВА 5

СОРТИРОВКА

Нет дела, коего устройство было бы труднее,

ведение опаснее, а успех сомнительнее,

нежели замена старых порядков новыми.

— НИККОЛО МАКИАВЕЛЛИ, Государь A513)

"Но мы не успеем просмотреть все номера автомобилей"

— возразил Дрейк.

"А нам и не нужно этого делать. Пол. Мы просто

расположим их по порядку и поищем одинаковые."

— ПЕРРИ МЕЙСОН, ИЗ ТЛе Case of the Angry Mourner A951)

Компьютер "Treesort": при новом "компьютерном подходе"

к изучению природы вы получите возможность быстро распознавать

более 260 видов деревьев США, Аляски и Канады, включая пальмы,

растительность пустынь и прочую "экзотику". Чтобы определить

породу дерева, достаточно просто вставить спицу.

— Каталог Edmund Scientific Company A964)

В ЭТОЙ ГЛАВЕ мы изучим вопрос, который часто возникает в программировании:

переразмещение элементов в порядке возрастания или убывания. Представьте, на-

насколько трудно было бы пользоваться словарем, если бы слова в нем не распо-

располагались в алфавитном порядке. Точно так же от порядка, в котором хранятся

элементы в памяти компьютера, во многом зависит скорость выполнения и простота

алгоритмов, предназначенных для их обработки.

Хотя в словарях слово "сортировка" (sorting) определяется как процесс раз-

разделения объектов по виду или сорту, программисты традиционно используют его

в гораздо более узком смысле, обозначая им такую перестановку предметов, при

которой они располагаются в порядке возрастания или убывания. Такой процесс,

пожалуй, следовало бы назвать не сортировкой, а упорядочением (ordering), но ис-

использование этого слова привело бы к путанице из-за перегруженности значениями

слова "порядок". Рассмотрим, например, следующее предложение: "Так как только

два из имеющихся у нас лентопротяжных механизмов в порядке, меня призвали к

порядку и обязали в срочном порядке заказать еще несколько устройств, чтобы мож-

можно было упорядочивать данные разного порядка на несколько порядков быстрее"

В математической терминологии это слово также изобилует значениями (порядок

группы, порядок перестановки, порядок точки ветвления, отношение порядка и

т. п.). Итак, слово "порядок" приводит к хаосу.

В качестве обозначения для процесса упорядочения предлагалось также слово

"ранжирование" (sequencing), но оно во многих случаях, по-видимому, не вполне

отражает суть дела, особенно если присутствуют равные элементы, и, кроме того,

иногда не согласуется с другими терминами. Конечно, слово "сортировка" и само

имеет довольно много значений, но оно прочно вошло в программистский жаргон.

Поэтому мы без дальнейших извинений будем использовать слово "сортировка"

в узком смысле: ''размещение по порядку". Вот некоторые из наиболее важных

областей применения сортировки.

a) Решение задачи группирования, когда нужно собрать вместе все элементы с

одинаковыми значениями некоторого признака. Допустим, имеется 10 000 элемен-

элементов, расположенных в случайном порядке, причем значения многих из них равны и

нужно переупорядочить массив так, чтобы элементы с равными значениями зани-

занимали соседние позиции в массиве. Это, по существу, тоже задача "сортировки", но в

более широком смысле, и она легко может быть решена путем сортировки массива в

указанном выше узком смысле, а именно — в результате расположения элементов в

порядке неубывания vi < v-2 < ¦ ¦ • < «юооо- Эффект, который может быть достигнут

после выполнения этой процедуры, и объясняет изменение первоначального смысла

слова "сортировка"

b) Поиск общих элементов в двух или более массивах. Если два или более мас-

массивов рассортировать в одном и том же порядке, то можно отыскать в них все

общие элементы за один последовательный просмотр всех массивов без возвратов.

Именно этим принципом и воспользовался Перри Мейсон, чтобы раскрыть дело

об убийстве (см. эпиграфы к этой главе). Оказывается, что, как правило, гораздо

удобнее просматривать список последовательно, а не перескакивая с места на место

случайным образом, если только список не настолько мал, что он целиком помеща-

помещается в оперативной памяти. Сортировка позволяет использовать последовательный

доступ к большим массивам в качестве приемлемой замены прямой адресации.

c) Поиск информации по значениям ключей. Как мы узнаем из главы б, сортиров-

сортировка используется и при поиске; с ее помощью можно сделать результаты обработки

данных более удобными для восприятия человеком. В самом деле, подготовленный

компьютером список, рассортированный в алфавитном порядке, зачастую выгля-

выглядит весьма внушительно, даже если содержащиеся в нем числовые данные были

рассчитаны неверно.

Хотя сортировка традиционно и большей частью использовалась для обработки

коммерческих данных, в действительности она является инструментом, полезным

в самых разных ситуациях, и поэтому о ней не следует забывать. В упр. 2.3.2-17

мы обсудили ее применение для упрощения алгебраических формул. Упражнения,

приведенные ниже, иллюстрируют разнообразие типичных применений сортировки.

Одной из первых мощных программных систем, продемонстрировавших бога-

богатые возможности сортировки, был компилятор LARC Scientific Compiler, разрабо-

разработанный Дж. Эрдвином (J. Erdwinn) и Д. Е. Фергюсоном (D. E. Ferguson) в фирме

Computer Sciences Corporation в I960 году. В этом оптимизирующем компиляторе

для расширенного языка FORTRAN сортировка использовалась весьма интенсив-

интенсивно, так что различные алгоритмы компиляции работали с относящимися к ним

фрагментами исходного текста программы, расположенными в удобной последова-

тельности. На первом проходе осуществлялся лексический анализ, т. е. выделение

в исходной программе лексических единиц (лексем), каждая из которых соответ-

соответствует либо идентификатору (имени переменной), либо константе, либо оператору

и т. д. Каждая лексема получала несколько порядковых номеров. В результате

сортировки по именам и соответствующим порядковым номерам все фрагменты

текста, в которых использовался данный идентификатор, оказывались собранными

вместе. "Определяющие вхождения" специфицирующие идентификатор как имя

функции, простую (параметр) или многомерную (массив) переменную, получали

меньшие номера, поэтому они оказывались первыми в последовательности лексем,

которые соответствовали этому идентификатору. Тем самым облегчалась проверка

правильности употребления идентификаторов, распределение памяти с учетом де-

деклараций EQUIVALENCE и т. д. Собранная таким образом информация о каждом

идентификаторе присоединялась к соответствующей лексеме. Поэтому не было

необходимости хранить в оперативной памяти "таблицу символов" содержащую

сведения об идентификаторах. После такой обработки лексемы снова сортировались

по другому порядковому номеру; в результате в программе, по существу, восстанав-

восстанавливался первоначальный порядок, если не считать того, что арифметические выра-

выражения оказывались записанными в более удобной "польской префиксной" форме.

Сортировка использовалась и на последующих фазах компиляции — для упро-

упрощения оптимизации циклов, включения в листинг сообщений об ошибках и т. д.

Короче говоря, компилятор был спроектирован так, что всю обработку файлов (а

для их хранения использовались весьма распространенные в те времена устройства

внешней памяти на магнитных барабанах) можно было выполнять последовательно.

Поэтому-то данные и снабжались такими порядковыми номерами, которые позво-

позволяли упорядочивать эти данные различными удобными способами.

По оценкам производителей компьютеров в 60-х годах в среднем более четверти

машинного времени тратилось на сортировку. Во многих вычислительных системах

на нее уходит больше половины машинного времени. Исходя из этих статистических

данных можно заключить, что либо (i) сортировка имеет много важных примене-

применений, либо (ii) ею часто пользуются без нужды, либо (ш) применяются в основ-

основном неэффективные алгоритмы сортировки. По-видимому, каждое из приведенных

предположений содержит долю истины.

Во всяком случае ясно, что сортировка заслуживает серьезного изучения с точки

зрения ее практического использования. Но даже если бы сортировка была почти

бесполезна, нашлась бы масса других причин заняться ею! Появление изощренных

алгоритмов сортировки говорит о том, что она и сама по себе интересна как объект

исследования. В этой области существует множество увлекательных нерешенных

задач наряду с весьма немногими уже решенными.

Рассматривая вопрос в более широком плане, мы обнаружим, что алгоритмы

сортировки представляют собой интересный частный пример того, как следует

подходить к решению проблем программирования вообще. Мы познакомимся со

многими важными принципами манипулирования структурами данных и просле-

проследим за эволюцией различных методов сортировки, причем читателю часто будет

предоставлена возможность самостоятельно "изобрести велосипед" как будто бы до

него никто с подобными задачами не сталкивался. Обобщение этих частных методов

позволит нам в значительной степени овладеть теми подходами, которые помогут

создавать качественные алгоритмы для решения других проблем, связанных с ис-

использованием компьютеров.

Методы сортировки служат великолепной иллюстрацией базовых концепций

анализа алгоритмов, т. е. оценки качества алгоритмов, что, в свою очередь, по-

позволяет разумно делать выбор среди, казалось бы, равноценных методов. Читате-

Читатели, имеющие склонность к математике, найдут в этой главе немало поучительных

способов оценки скорости работы алгоритмов и методов решения сложных рекур-

рекуррентных соотношений. С другой стороны, изложение построено так, что читатели,

не имеющие такой склонности, могут безболезненно пропускать выкладки.

Прежде чем двигаться дальше, необходимо более четко сформулировать задачу

и ввести соответствующую терминологию. Пусть надо упорядочить N элементов

i?i,i?2, ¦ ¦ ¦ ,Rn-

Назовем их записями, а всю совокупность N записей назовем файлом. Каждая

запись Rj имеет ключ, Kj, который и управляет процессом сортировки. Помимо

ключа, запись может содержать дополнительную "сопутствующую информацию",

которая не влияет на сортировку, но всегда остается в этой записи.

Отношение порядка "<" на множестве ключей вводится таким образом, чтобы

для любых трех значений ключей а, 6, с выполнялись следующие условия:

i) справедливо одно и только одно из соотношений а < b, a = b, b < а (закон

трихотомии);

И) если а < 6 и 6 < с, то а < с (закон транзитивности).

Эти два свойства определяют математическое понятие линейного упорядочения,

называемого также совершенным упорядочением. Любое множество с отношением

"<", удовлетворяющим обоим этим свойствам, поддается сортировке большинством

методов, описанных в этой главе, хотя некоторые из методов годятся только для

числовых и буквенных ключей с общепринятым отношением порядка.

Задача сортировки — найти такую перестановку записей рA)рB).. .p(N) с

индексами {1,2,..., N}, после которой ключи расположились бы в порядке неубы-

неубывания:

Kp(i) < Кр{2) < ¦ ¦ ¦ < Kp{N). A)

Сортировка называется устойчивой, если она удовлетворяет такому дополнитель-

дополнительному условию, что записи с одинаковыми ключами остаются в прежнем порядке,

т. е., другими словами,

Р@ < P(j) Для любых Kp(i) = Kp(j) и i < j. B)

В одних случаях придется физически перемещать записи в памяти так, чтобы их

ключи были упорядочены; в других случаях достаточно создать вспомогательную

таблицу, которая некоторым образом описывает перестановку и обеспечивает доступ

к записям в соответствии с порядком их ключей.

Некоторые методы сортировки предполагают существование величин "сю" и

"—оо" или одной из них. Величина "оо" считается больше, а величина "—сю" меньше

любого ключа:

-оо < Kj < оо для l<j<N. C)

Эти величины используются в качестве искусственных ключей, а также гранич-

граничных признаков. Равенство в C), вообще говоря, исключено. Если же оно, тем не ме-

менее, допускается, алгоритмы можно модифицировать так, чтобы они все-таки рабо-

работали, хотя нередко при этом их изящество и эффективность отчасти утрачиваются.

Обычно методы сортировки подразделяют на два класса: внутренние, когда все

записи хранятся в быстрой оперативной памяти, и внешние, когда все записи в ней

не помещаются. Методы внутренней сортировки обеспечивают большую гибкость

при построении структур данных и доступа к ним, внешние же методы обеспечивают

достижение нужного результата в "спартанских" условиях ограниченных ресурсов.

Достаточно хороший общий алгоритм затрачивает на сортировку N записей вре-

время пропорционально N log N; при этом требуется около log N "проходов" по данным.

Как мы увидим в разделе 5.3.1, это минимальное время, если записи расположены

в произвольном порядке и сортировка выполняется попарным сравнением ключей.

Так, если удвоить число записей, то и время при прочих равных условиях возрастет

немногим более чем вдвое. (На самом деле, когда N неограниченно возрастает,

время сортировки растет как N(logNJ, если все ключи различны, поскольку и

размеры ключей увеличиваются, как минимум, пропорционально log N с ростом TV;

но практически N всегда остается ограниченным.)

С другой стороны, если известно, что ключи являются случайными величинами

с некоторым непрерывным распределением, то, как мы увидим ниже, сортировка

может быть выполнена в среднем за O(N) шагов.

УПРАЖНЕНИЯ (часть 1)

1. [М20] Докажите, что из законов трихотомии и транзитивности вытекает единствен-

единственность перестановки рA)рB).. .p(N), если сортировка устойчива.

2. [21] Пусть каждая запись Д,- некоторого файла имеет два ключа: "большой ключ"

Kj и "малый ключ" kj, причем оба множества ключей линейно упорядочены. Тогда можно

обычным способом ввести лексикографический порядок на множестве пар ключей (К, к):

(Ki,ki) <(Kj,kj), если Kt < К, или K{ = Kj и ki<kj.

Алиса рассортировала этот файл сначала по большим ключам, получив п групп запи-

записей с одинаковыми большими ключами в каждой группе:

•^p(i) = • ¦ • = Kpfa) < #P(ii+i) = ¦ • • = Kp(i2) <¦¦¦< A"p(in_1+i) = • ¦ • = Kp(in),

где in = N. Затем она рассортировала каждую из п групп йр(^._1+1),..., i?p(ij) по соб-

собственным малым ключам.

Билл взял тот же исходный файл и сначала рассортировал его по малым ключам, а

затем получившийся файл рассортировал по большим ключам.

Взяв тот же исходный файл, Крис рассортировал его один раз в лексикографическом

порядке, пользуясь парами ключей (Kj,kj).

Получилось ли у всех троих одно и то же?

3. [М25] Пусть на множестве К\,..., Kn определено отношение "<", для которого закон

трихотомии выполняется, а закон транзитивности — нет. Докажите, что и в этом случае

возможна устойчивая сортировка записей, т. е. сортировка, при которой выполняются

условия A) и B). (На самом деле существует, по крайней мере, три расположения записей,

удовлетворяющих этим условиям!)

> 4. [21] Составители словарей фактически не следуют жестко лексикографическому по-

порядку, так как прописные и строчные буквы у них перемежаются. В частности, использу-

используется такой порядок:

а < Ajaa < АА < ААА < Aachen < aah < • • • < zzz < ZZZ.

Поясните, как реализовать подобный словарный порядок сортировки.

> 5. [М28] Разработайте двоичный код для всех неотрицательных целых чисел, такой, что,

если п закодировано в виде строки /з(гг), то т < п тогда и только тогда, когда р(т) меньше

в лексикографическом смысле, чем р(п). Более того, р(т) не должно быть префиксом

р(п) для любого m ф п. По возможности длина р(п) должна быть по крайней мере lg n +

O(log log n) для всех больших п. (Такой способ кодирования очень удобен, если приходится

сортировать текст, состоящий из чисел и слов, или если желательно отобразить довольно

большие текстовые последовательности на двоичные коды.)

6. [15] Программисту на MIX B.C. Даллу потребовалось выяснить, находится ли в ячейке

А число, большее числа из ячейки В, меньшее или же равное ему. Он написал в программе

"LDA A: SUB В'! а потом проверил, какой результат получился в регистре А: положитель-

положительный, отрицательный или нуль. Какую серьезную ошибку он допустил и как должен был

поступить?

7. [17] Напишите подпрограмму для компьютера MIX для сравнения ключей с увеличен-

увеличенной точностью, исходя из следующих условий.

Вызов: JMP COMPARE

Состояние при входе: rll = n; CONTENTS (А + к) = a,k и CONTENTS (В + к) = bk

для 1 < к < п; полагается, что п > 1.

Состояние при выходе: CI = GREATER, если (а„,... ,а\) > (Ьп,...,6i);

CI = EQUAL, если (а„, ... ,<и) = {Ьп,... ,6i);

CI = LESS, если (ап,... , <ц) < (bn,... ,bi);

rX и rll, возможно, изменились.

Здесь отношение (an,...,ai) < (bn,...,bj) обозначает лексикографическое упорядочение

слева направо, т. е. существует индекс j, такой, что a/t = 6^ для п > к > j, но a, < bj.

> 8. [50] В ячейках А и В содержатся соответственно числа а и 6. Покажите, что можно

написать программу для MIX, которая вычисляла бы min(a, 6) и записывала результат в

ячейку С, не пользуясь командами перехода. (Предостережение. Поскольку арифметичес-

арифметическое переполнение невозможно обнаружить без операторов перехода, разумно так построить

программу, чтобы переполнение не могло возникнуть ни при каких значениях а и Ь.)

9. [М27] Какова вероятность того, что после сортировки в порядке неубывания п неза-

независимых равномерно распределенных на отрезке [0, 1] случайных величин г-е от начала

число окажется < х?

УПРАЖНЕНИЯ (часть 2)

В каждом из этих упражнений поставлена задача, с которой может столкнуться програм-

программист. Предложите хорошее решение задачи, предполагая, что вы имеете дело с "музей-

"музейным" компьютером, у которого имеется сравнительно небольшая оперативная память,

порядка нескольких тысяч слов и около полудюжины накопителей на магнитной ленте

(НМЛ) — этого количества вполне достаточно для выполнения сортировки. Алгоритм,

который сможет эффективно работать в таких "спартанских" условиях, тем более будет

прекрасно выполнять задачу на современных компьютерах.

10. [15] Имеется лента, на которой записан миллион слов данных. Как определить,

сколько на этой ленте различных слов?

11. [18] Вообразите себя в роли Управления внутренних доходов Министерства финансов

США. Вы получаете миллионы информационных карточек от организаций о том, сколько

денег они выплатили различным лицам, и миллионы налоговых деклараций (карточек) о

доходах от налогоплательщиков. Как бы вы стали отыскивать людей, которые сообщили

не обо всех своих доходах?

12. [М25] (Транспонирование матрицы.) Имеется магнитная лента, содержащая милли-

миллион слов, которые представляют собой элементы матрицы 1000 х 1000, записанные по стро-

строкам: ai,i aj,2 • •. ai.iooo 12,1 • ¦ ¦ йг.юоо •. • яюоодооо- Ваша задача — получить ленту, на кото-

которой элементы этой матрицы были бы записаны по столбцам: ai,i a2,i ... aiooo.i ai,2 ¦ ¦ ¦ «1000,2

•. ¦ aiooo.iooo- (Постарайтесь сделать не более десяти просмотров данных.)

13. [М26] В вашем распоряжении есть довольно большой файл из ./V слов. Как бы вы его

"перетасовали" случайным образом?

14. [20] Вы работаете с двумя вычислительными системами, в которых по-разному упо-

упорядочены литеры (буквы и цифры). Как заставить первую систему сортировать файлы с

буквенно-цифровой информацией, предназначенные для использования во второй системе?

15. [18] Имеется довольно большой список людей, родившихся в США, с указанием шта-

штата, в котором они родились. Как подсчитать тех, кто родился в каждом штате? (Предпо-

(Предполагается, что ни один человек не указан в списке более одного раза.)

16. [20] Чтобы облегчить внесение изменений в большие программы, написанные на язы-

языке FORTRAN, желательно написать программу, которая формирует таблицу перекрестных

ссылок. Входными данными для нее служит программа на FORTRAN, а в результате полу-

получается листинг исходной программы, снабженный указателем всех случаев употребления

каждого идентификатора (т. е. имени) в программе. Как написать такую программу?

> 17. [33] (Сортировка библиографических карточек каталога.) До появления компьютер-

компьютерных баз данных в каждой библиотеке существовал каталог библиографических карточек,

с помощью которого читатели могли отыскать интересующие их издания. Но сортировка

карточек в порядке, удобном для читателей, усложняется по мере увеличения библиотечно-

библиотечного фонда. В следующем "алфавитном" списке содержатся рекомендации, взятые из правил

регистрации и хранения каталожных карточек Американской библиотечной ассоциации

(Чикаго, 1942).

Текст карточки Замечания

R. Accademia nazionale dei Lincei, В названиях иностранных (кроме британских)

Rome учреждений слово "royalty" (королевский)

игнорируется

1812; em historischer Roman Achtzehnhundertzwolf (числительное 1812 на

немецком языке)

Bibliotheque d'histoire revolutionnaire В французском тексте апостроф рассматривается

как пробел

Bibliotheque des curiosites Диатонические Знаки игнорируются

Brown, Mrs. J. Crosby Указание положения (Mrs.) игнорируется

Brown, John Фамилии с датами следуют за фамилиями без дат

Brown, John, mathematician ..., которые упорядочиваются

Brown, John, of Boston по описательным словам

Brown, John, 1715-1766 Одинаковые фамилии упорядочиваются по датам

рождения

BROWN, JOHN, 1715-1766 Работы о нем идут после его работ

Brown, John, d. 1811 Иногда год рождения определяется приблизи-

приблизительно

Текст карточки

Brown, Dr. John, 1810-1882

Brown-Williams, Reginald Makepeace

Brown America

Brown & Dallison's Nevada directory

Brownjohn, Alan

Den', Vladimir Eduardovich, 1867-

The den

Den lieben langen Tag

Dix, Morgan, 1827-1908

1812 ouverture

Le XIXe siecle frangais

The 1847 issue of U. S. stamps

1812 overture

I am a mathematician

IBM journal of research and

development

ha-I ha-ehad

la; a love story

International Business Machines

Corporation

al-KhuwarizmT, Muhammad ibn Musa,

ft. 813-846

Labour. A magazine for all workers

Labor research association

Labour, see Labor

McCall's cookbook

McCarthy, John, 1927-

Machine-independent computer

programming.

MacMahon, Maj. Percy Alexander,

1854-1929

Mrs. Dalloway

Mistress of mistresses

Royal society of London

St. Petersburger Zeitung

Saint-Sae'ns, Camille, 1835-1921

Ste-Marie, Gaston P

Seminumerical algorithms

Uncle Tom's cabin

U. S. bureau of the census

Замечания

Указание положения (Dr.) игнорируется

Дефис рассматривается как пробел

Названия книг указываются после составных

фамилий

& в английском тексте превращается в "and"

Апостроф в именах игнорируется

Артикль в начале текста игнорируется

..., если существительное стоит в именительном

падеже

Фамилии идут раньше других слов

Dix-huit cent douze (числительное 1812 на фран-

французском языке)

Dix-neuvieme (числительное XIX-й на француз-

французском языке)

Eighteen forty-seven (числительное 1847 на англий-

английском языке)

Eighteen twelve (числительное 1812 на английском

языке)

(a book by Norbert Wiener) (книга Норберта

Винера)

Аббревиатуры рассматриваются как ряд однобук-

венных слов

Артикль в начале текста игнорируется

Знаки препинания в названиях игнорируются

Начальное "al-" в арабских именах игнорируется

Заменяется словом "Labor"

Ссылка на другую карточку в картотеке

Апостроф в английском тексте игнорируется

Me = Mac

Дефис рассматривается как пробел

Указание положения (Maj.) игнорируется

"Mrs." заменяется словом "Mistress"

В названиях британских учреждений слово

"royalty" (королевский) учитывается

"St." заменяется словом "Saint", даже в немецком

тексте

Дефис рассматривается как пробел

Sainte

(a book by Donald Ervin Knuth)

(a book by Harriet Beecher Stowe)

"U. S." заменяется словами "United States"

Текст карточки Замечания

Vandermonde, Alexandre Theophile,

1735-1796

Van Valkenburg, Mac Elwyn, 1921- Пробел после префикса в фамилиях игнорируется

Von Neumann, John, 1903-1957

The whole art of legerdemain Артикль в начале текста игнорируется

Who's afraid of Virginia Woolf ? Апостроф в текстах на английском языке игнори-

игнорируется

Wijngaarden, Adriaan van, 1916- Фамилия никогда не начинается со строчной

литеры

(У большинства из этих правил есть исключения; кроме того, существует много других

правил, которые здесь не упомянуты.)

Предположим, вам поручено рассортировать большое количество таких карточек с

помощью компьютера, а затем обслуживать огромную картотеку, причем у вас нет возмож-

возможности изменить уже сложившийся порядок заполнения карточек. Как бы вы организовали

информацию, чтобы упростить операции сортировки и включения новых карточек?

18. [М25] (Э. Т. Паркер (Е. Т. Parker).) Леонард Эйлер высказал предположение [iVova

Ada Acad. Sci. Petropolhanse 13 A795), 45-63, §3; написана в 1778], что уравнение

и6 + v6 + w6 + х6 + у6 = z6

не имеет нетривиальных решений среди целых неотрицательных чисел и, v, w, х, у, z.

Одновременно он предположил, что уравнение

не имеет решения в положительных целых числах при п > 3, но это предположение было

опровергнуто уже в наше время, когда с помощью компьютера было найдено тождество

275 + 845 + 1105 + 1335 = 1445 [см. L. J. Lander, Т. R. Parkin, and J. L. Selfridge, Math. Сотр.

21 A967), 446-459]. Множество аналогичных примеров было обнаружено и при п = 4

Н. Д. Элкисом (N. D. Elkies) [Math. Сотр. 51 A988), 825-835]. Подумайте, как можно

было бы использовать сортировку для поиска примеров, опровергающих предположение

Эйлера при п = 6.

> 19. [24] Файл содержит большое количество 30-разрядных двоичных слов: xi,...,xt/.

Придумайте хороший способ нахождения в нем всех пар с взаимно дополняющими эле-

элементами {xi,Xj}. (Два слова называются взаимно дополняющими, если второе содержит

нули во всех разрядах, в которых были единицы в первом слове, и наоборот; таким образом,

они взаимно дополняющие тогда и только тогда, когда их сумма равна A1... 1J, если они

рассматриваются как двоичные числа.)

> 20. [25] Имеется файл, содержащий тысячу 30-разрядных двоичных слов xi,..., хюоо-

Как бы вы стали составлять список всех пар (xi,Xj), таких, что xt отличается от ж3- не

более чем в двух разрядах?

21. [22] Как бы вы поступили, если бы вам нужно было найти все пятибуквенные ана-

анаграммы, такие как CARET, CARTE, CATER, CRATE, REACT, RECTA, TRACE; CRUEL, LUCRE, ULCER;

DOWRY, ROWDY, WORDY? [Или если бы вы, допустим, захотели узнать, существуют ли в

английском языке наборы из десяти или более анаграмм, кроме замечательной серии

APERS, ASPER, PARES, PARSE, PEARS, PRASE, PRESA, RAPES, REAPS, SPAER, SPARE, SPEAR,

к которой можно еще добавить французское слово APRES.]

22. [M28] Пусть даны описания весьма большого числа ориентированных графов. Как

можно сгруппировать изоморфные графы? (Два ориентированных графа называются

изоморфными, если существует взаимно однозначное соответствие между их вершинами и

взаимно однозначное соответствие между их дугами, причем эти соответствия сохраняют

инцидентность вершин и дуг.)

23. [30] В некоторой группе из 4 096 человек каждый имеет около 100 знакомых. Был

составлен список всех пар людей, знакомых друг с другом. (Это отношение симметрично,

т. е. если х знаком с у, то и у знаком с х. Поэтому в списке содержится примерно 200 000

пар.) Придумайте алгоритм, который по заданному к выдавал бы все клики из к человек.

(Клика — это группа людей, в которой все знают друг друга.) Предполагается, что не

бывает слишком больших клик (размером более 25).

> 24. [30] Три миллиона человек с различными именами были уложены рядом непрерывной

цепочкой от Нью-Йорка до Калифорнии. Каждому из них дали листок бумаги, на котором

он написал свое имя и имя своего ближайшего западного соседа. Человек, находивший-

находившийся в крайней западной точке цепи, не понял, что ему делать, и выбросил свой листок.

Остальные 2 999 999 листков собрали в большую корзину и отправили в Национальный

архив, в Вашингтон, округ Колумбия. Там содержимое корзины тщательно перетасовали

и записали на магнитные ленты.

Специалист по теории информации определил, что имеется достаточно сведений для

восстановления списка людей в исходном порядке. Программист нашел способ сделать это

менее чем за 1 000 просмотров лент с данными, используя лишь последовательный доступ

к файлам на лентах и небольшой объем оперативной памяти. Как ему это удалось?

[Другими словами, как, имея расположенные произвольным образом пары (x;,Zi+i),

1 < г < Лг, где все ж; различны, получить последовательность х\х? . . . xjv, применяя лишь

методы последовательной обработки данных, которые пригодны для работы с магнитными

лентами? Это сортировка в случае, когда трудно определить, какой из двух ключей

предшествует другому; мы уже поднимали этот вопрос в упр. 2.2.3-25.]

25. [М21] (Дискретные логарифмы.) Пусть известно, что р — простое число (довольно

большое), а о — первообразный корень по модулю р. Следовательно, для любого Ь в

диапазоне 1 < Ъ < р существует единственное п, такое, что a" modp = Ь, 1 < п < р. (Это

п называется индексом Ь по модулю р по отношению к а.) Как по заданному Ь найти п

менее чем за п(п) шагов. [Указание. Пусть т = Ч\/р]. Попытайтесь решить уравнение

amni = Ьа~П2 (по модулю р) при 0 < п\,П2 < т]

*5.1. КОМБИНАТОРНЫЕ СВОЙСТВА ПЕРЕСТАНОВОК

Перестановкой конечного множества называется некоторое расположение его эле-

элементов в ряд. Перестановки особенно важны при изучении алгоритмов сортировки,

так как они служат для представления неупорядоченных исходных данных. Чтобы

исследовать эффективность различных методов сортировки, нужно уметь подсчи-

подсчитывать количество перестановок, которые вынуждают повторять некоторый шаг

алгоритма определенное число раз.

Мы уже не раз встречались с перестановками в предыдущих главах. Например,

в разделе 1.2.5 обсуждались два основных теоретических метода построения п\

перестановок п объектов; в разделе 1.3.3 были проанализированы некоторые ал-

алгоритмы, связанные с циклической структурой и мультипликативными свойствами

перестановок; в разделе 3.3.2 изучались их серии монотонности. Цель настоящего

параграфа — описать другие свойства перестановок и рассмотреть общий случай,

когда допускается наличие одинаковых элементов. Попутно мы. многое узнаем о

комбинаторной математике.

Свойства перестановок настолько красивы, что представляют и самостоятель-

самостоятельный интерес. Удобно будет дать их систематическое изложение в одном месте,

а не разбрасывать материал по всей главе. Читателям, не имеющим склонности

к математике, а также тем, кто жаждет поскорее добраться до самих методов

сортировки, рекомендуется перейти сразу к разделу 5.2, потому что настоящий

раздел непосредственного отношения к сортировке почти не имеет.

*5.1.1. Инверсии

Пусть ai а,2 ¦¦¦ап — перестановка множества {1,2,... ,п}. Если i < j и а; > a.j,

то пара (a.i,aj) называется инверсией перестановки; например, перестановка 314 2

имеет три инверсии: C,1), C,2) и D,2). Каждая инверсия — это пара элементов,

"нарушающих порядок"; следовательно, единственная перестановка, не содержащая

инверсий, — это рассортированная перестановка 1 2... гг. Такая связь с сортировкой

и является главной причиной нашего интереса к инверсиям, хотя это понятие уже

использовалось, когда мы анализировали алгоритм динамического распределения

памяти (см. упр. 2.2.2-9).

Понятие инверсии ввел Г. Крамер в 1750 году в связи со своим замечатель-

замечательным правилом решения линейных уравнений [Intr. a I'Analyse des Lignes Courbes

Algebriques (Geneva, 1750), 657-659; см. также Thomas Muir, Theory of Determi-

Determinants 1 A906), 11-14]. В сущности, он определил детерминант п х п-матрицы

следующим образом:

(Хц Xi2 ••• х\п \

. : : I — 2_j\ > xlaix2a2 ¦ ¦ -хпап,

хп1 хп2 ¦ ¦¦ хпп/

где сумма берется по всем перестановкам aj аг ¦. • ап из {1,2,..., n}, a inv(ai 12 ¦ ¦ ¦

ап) — число инверсий в перестановке.

Таблица инверсий Ь\ Ьг ¦ • • Ьп перестановки aj аг ... ап образуется, если опреде-

определить bj как число элементов слева от j, которые больше, чем j. Другими словами,

bj — число инверсий, второй элемент которых равен j. Отсюда, например, следует,

что таблицей инверсий перестановки

591826473 A)

будет

2 3 6 4 0 2 2 10, B)

поскольку 5 и 9 расположены левее 1; 5, 9, 8 — левее 2 и т. д. Всего эта перестановка

имеет 20 инверсий. По определению числа bj всегда удовлетворяют неравенствам

0 < bi < n - 1, 0<Ь2<п-2, ..., 0 < Ь„_1 < 1, Ьп = 0. C)

Пожалуй, наиболее важный факт, касающийся перестановок и установленный

Маршаллом Холлом (Marshall Hall), состоит в том, что таблица инверсий един-

единственным образом определяет соответствующую перестановку. [См. Proc. Symp.

Applied Math. 6 (American Math. Society, 1956), 203.] Из любой таблицы инверсии

6i 62 • • • bn, удовлетворяющей условиям C), можно однозначно восстановить переста-

перестановку, которая ее породила, путем последовательного определения относительного

расположения элементов п,п-1, ...,1 (в этом порядке). Например, перестановку,

соответствующую B), можно построить следующим образом: выпишем число 9,

затем разместим 8 после 9, поскольку bs = 1. Аналогично установим 7 после и

8, и 9, поскольку bj — 2. Так как Ь& = 2, то 6 должно следовать за двумя уже

выписанными нами числами; таким образом, имеем промежуточный результат

986 7.

Продолжим, приписав 5 левее, поскольку 65 = 0; поместим 4 вслед за четырьмя из

уже записанных чисел, а 3 — после шести выписанных чисел (т. е. в правый конец)

и получим

5 9 8 6 4 7 3.

Вставив аналогичным образом 2 и 1, придем к A).

Такое соответствие важно, потому что часто можно заменить задачу, сформу-

сформулированную в терминах перестановок, эквивалентной ей задачей, сформулирован-

сформулированной в терминах таблиц инверсий, которая, возможно, решается проще. Рассмо-

Рассмотрим, например, самый простой вопрос: сколько существует перестановок множе-

множества {1,2,..., п}? Ответ должен быть равен числу всевозможных таблиц инверсий,

а их легко пересчитать, так как Ь\ можно выбрать п способами, 6г независимо

от Ь\ — п — 1 способами, ..., а Ьп — единственным способом; итого получаем

п(п — 1)... 1 = п! различных таблиц инверсий. Таблицы инверсий пересчитать легче,

потому что значения bk полностью не зависят друг от друга, в то время как а*

должны быть все различны.

В разделе 1.2.10 мы рассматривали задачу о числе локальных максимумов пе-

перестановки, если читать ее справа налево. Иными словами, требовалось подсчитать

количество элементов, каждый из которых больше любого из следующих после

него. (Например, правосторонние максимумы в A) — это 3, 7, 8 и 9.) Оно равно

количеству индексов j, таких, что bj имеет максимальное значение n — j. Так как

Ьх будет равно п — 1 с вероятностью 1/п и (независимо) &2 будет равно п — 2 с

вероятностью 1/(п - 1) и т. д., из рассмотрения инверсий ясно, что среднее число

правосторонних максимумов равно

1234

2134

1243

2314

>1423

4123

3241

4132

3421

4321

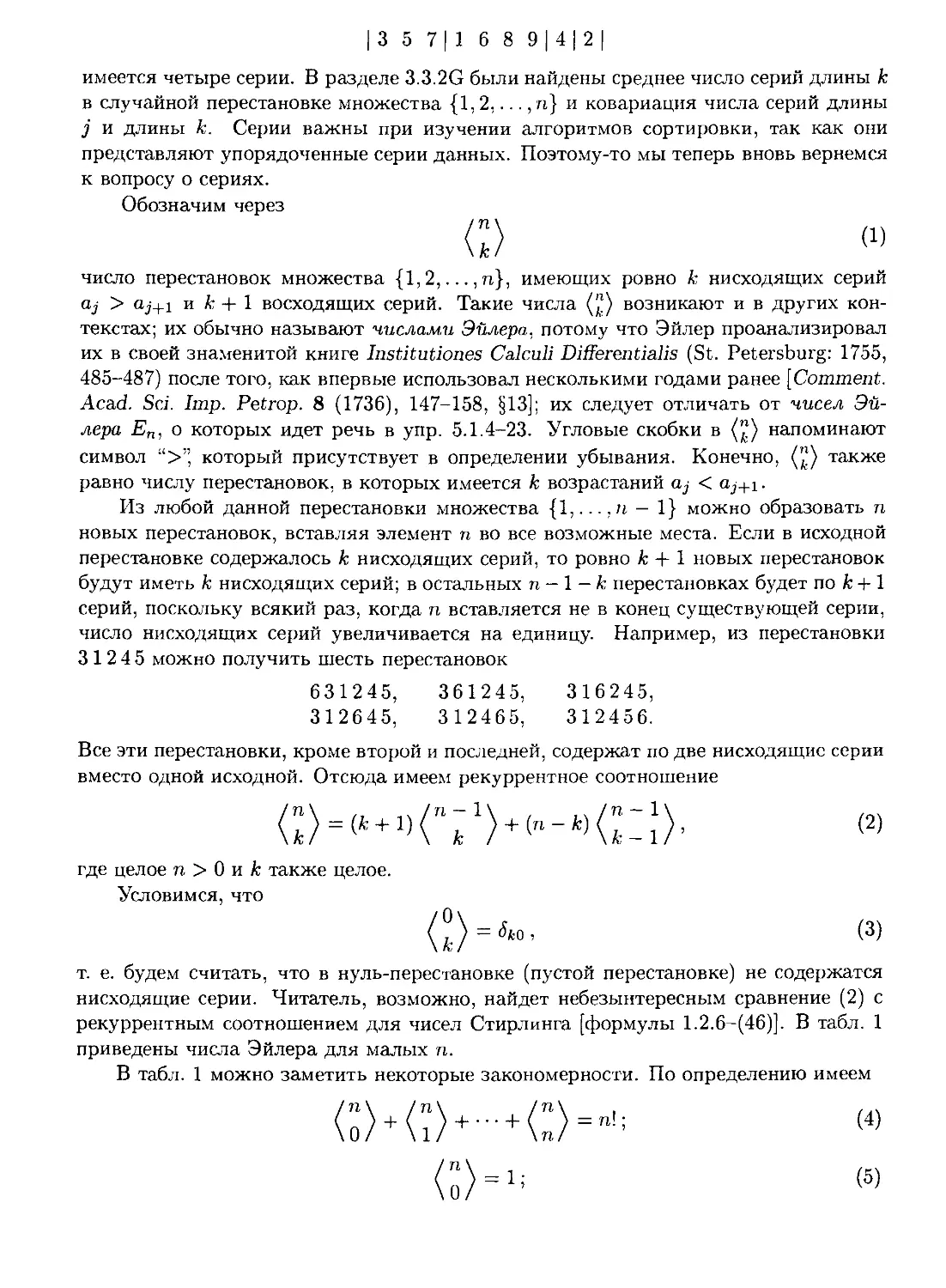

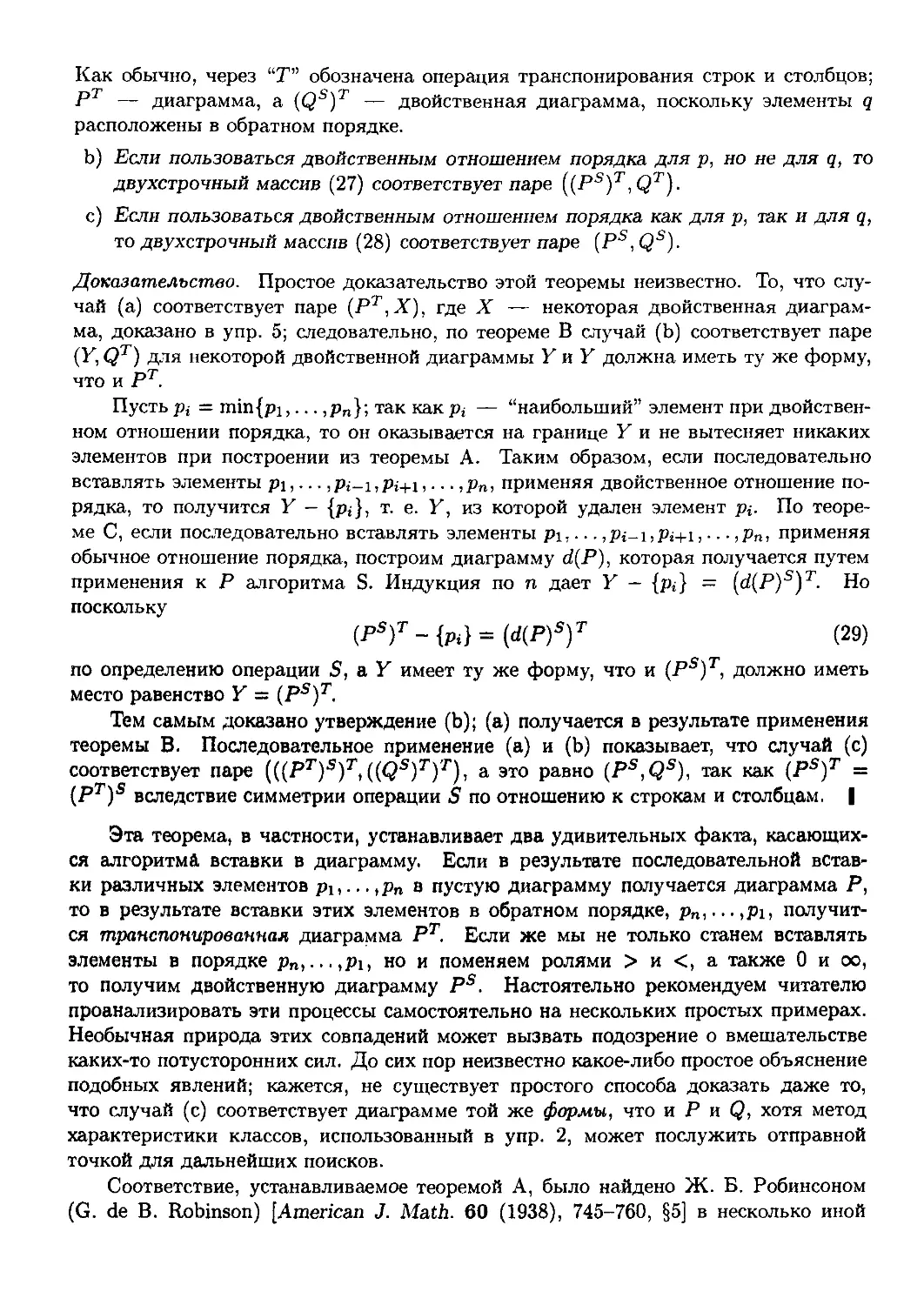

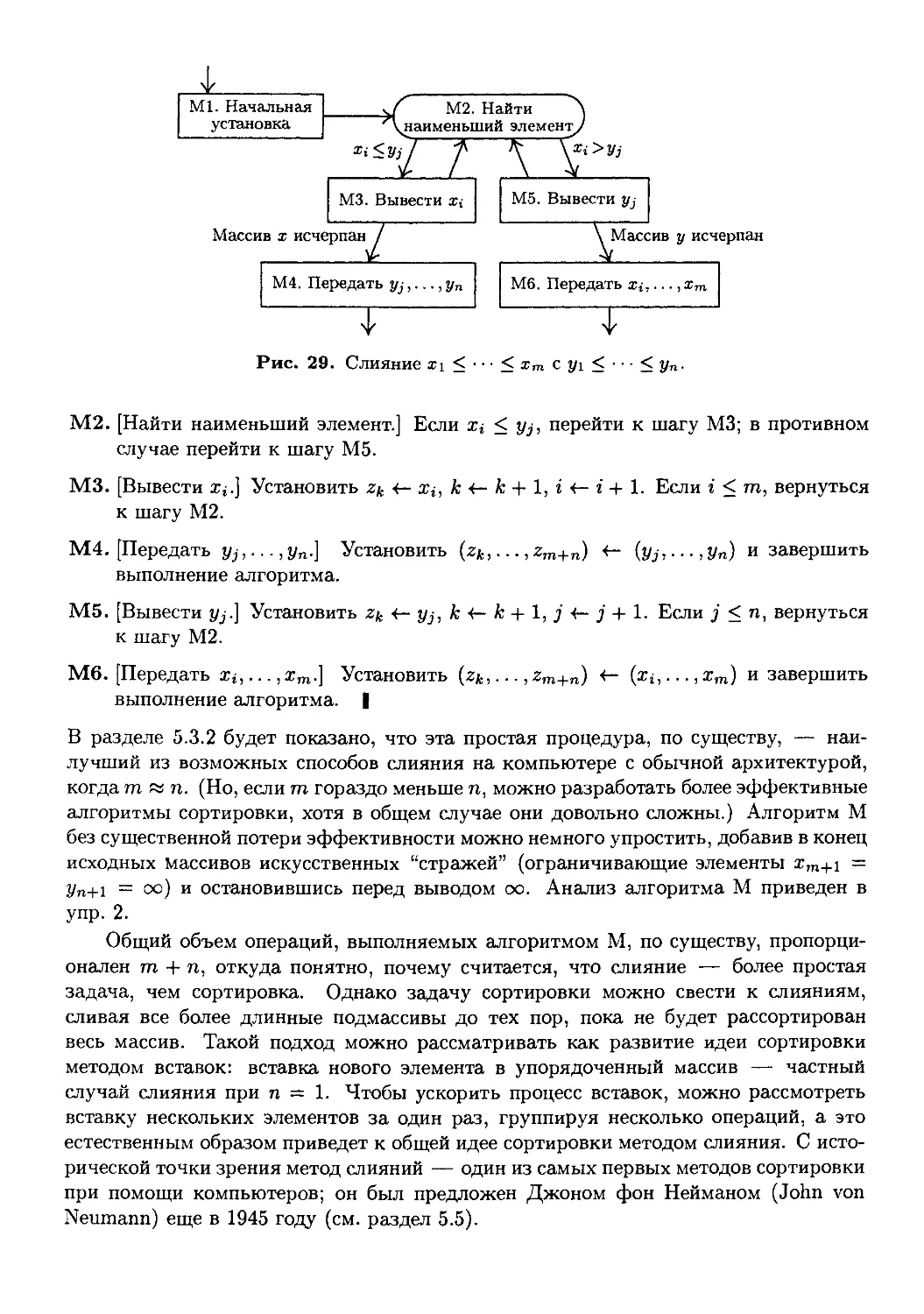

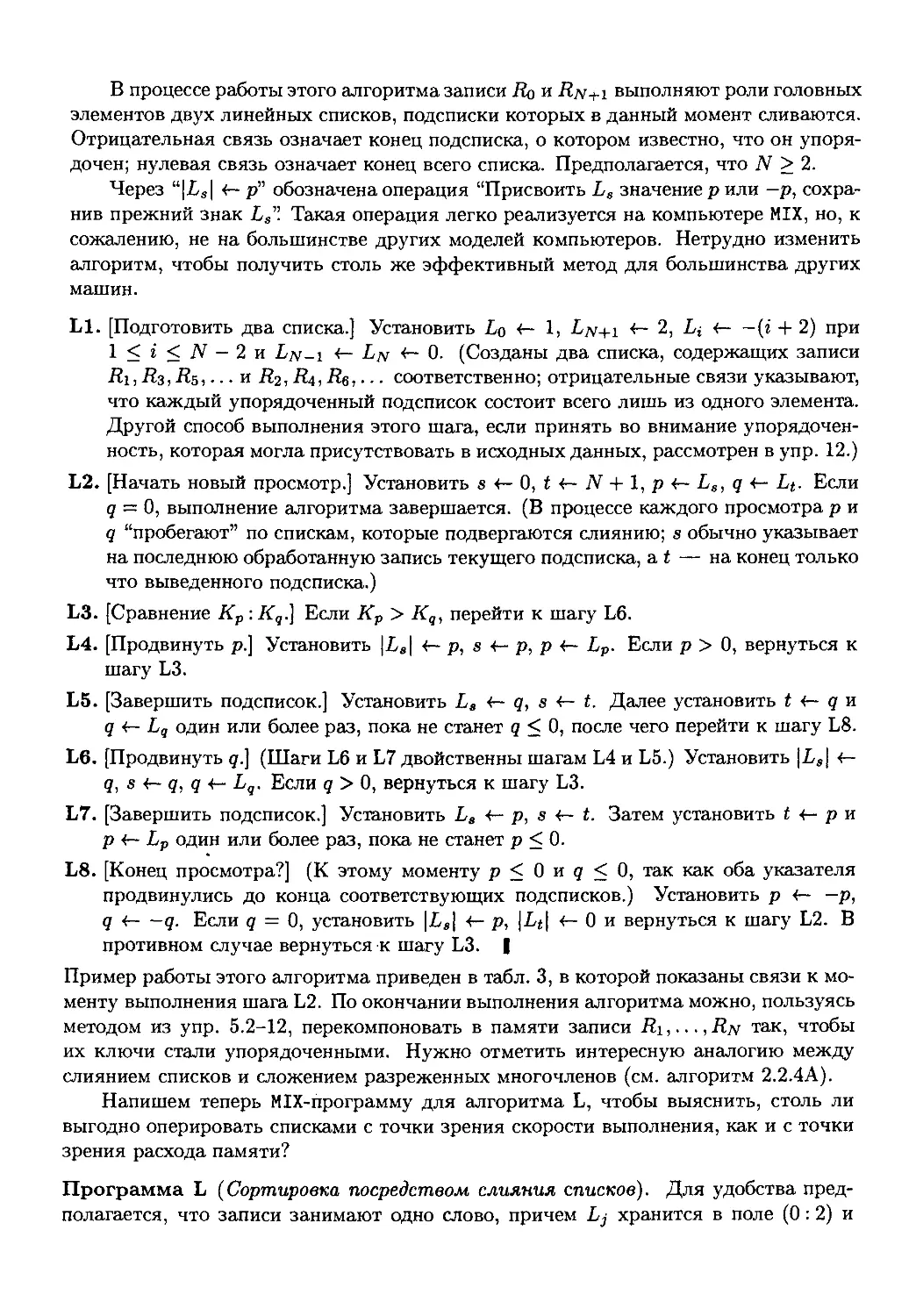

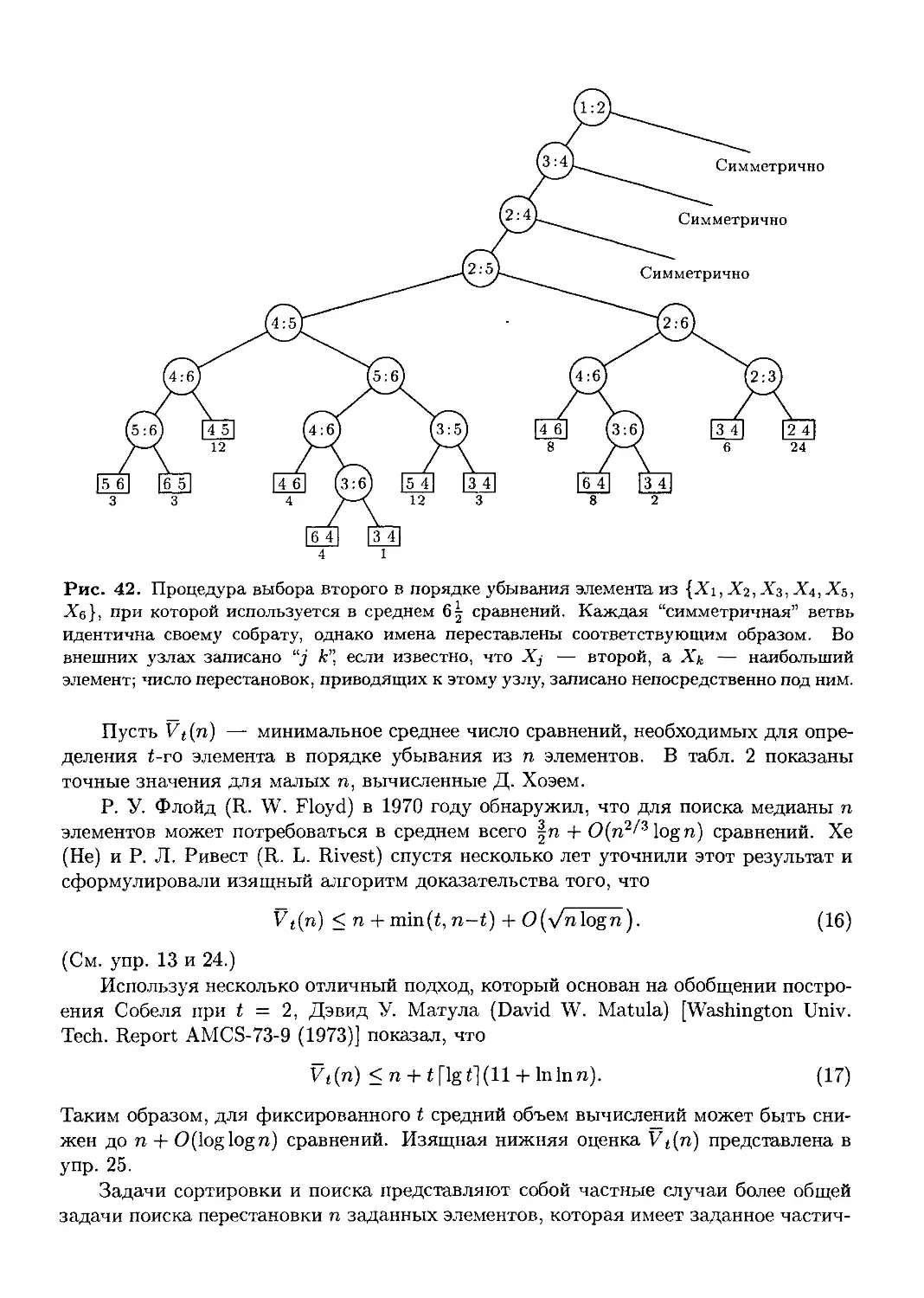

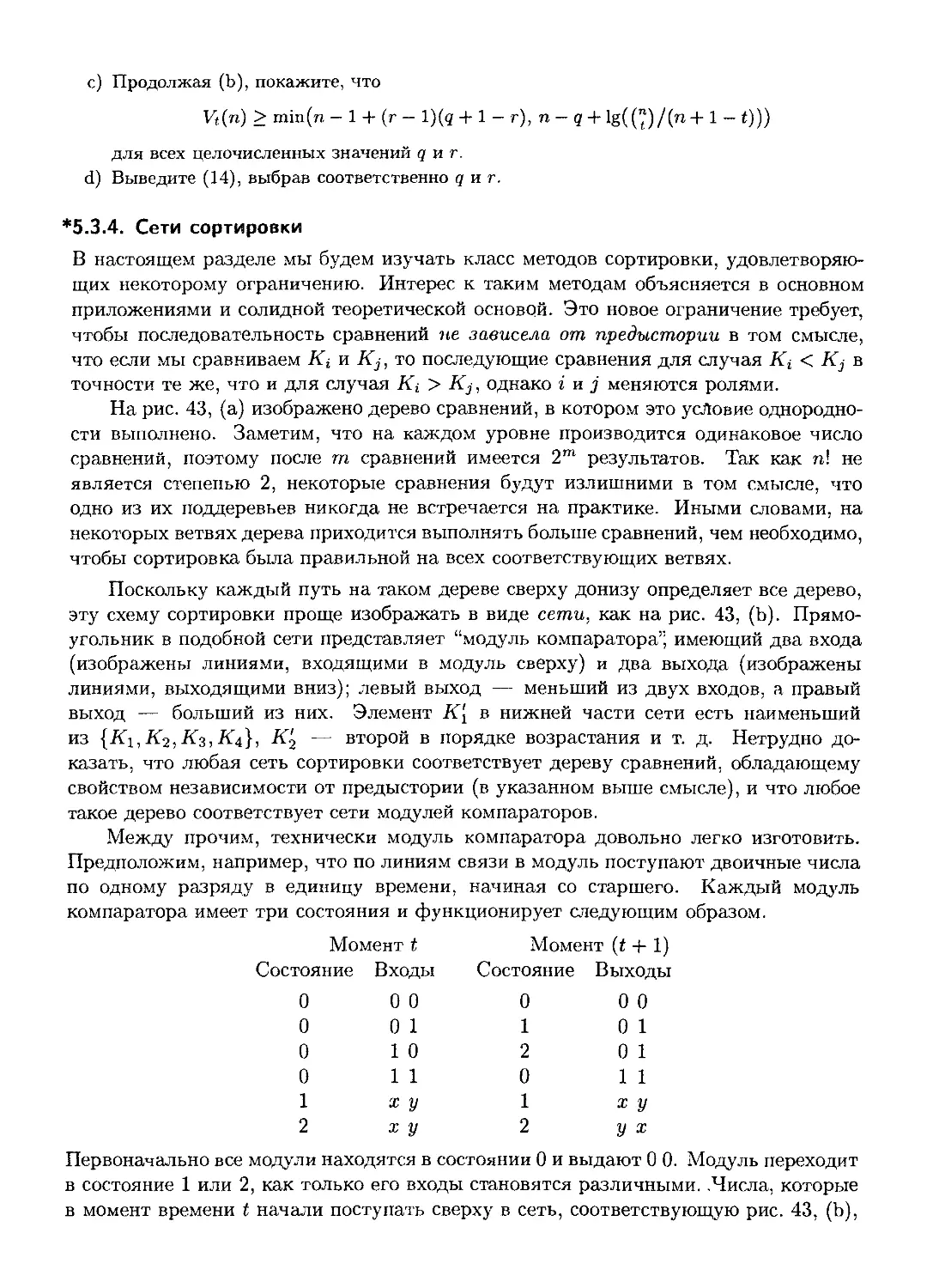

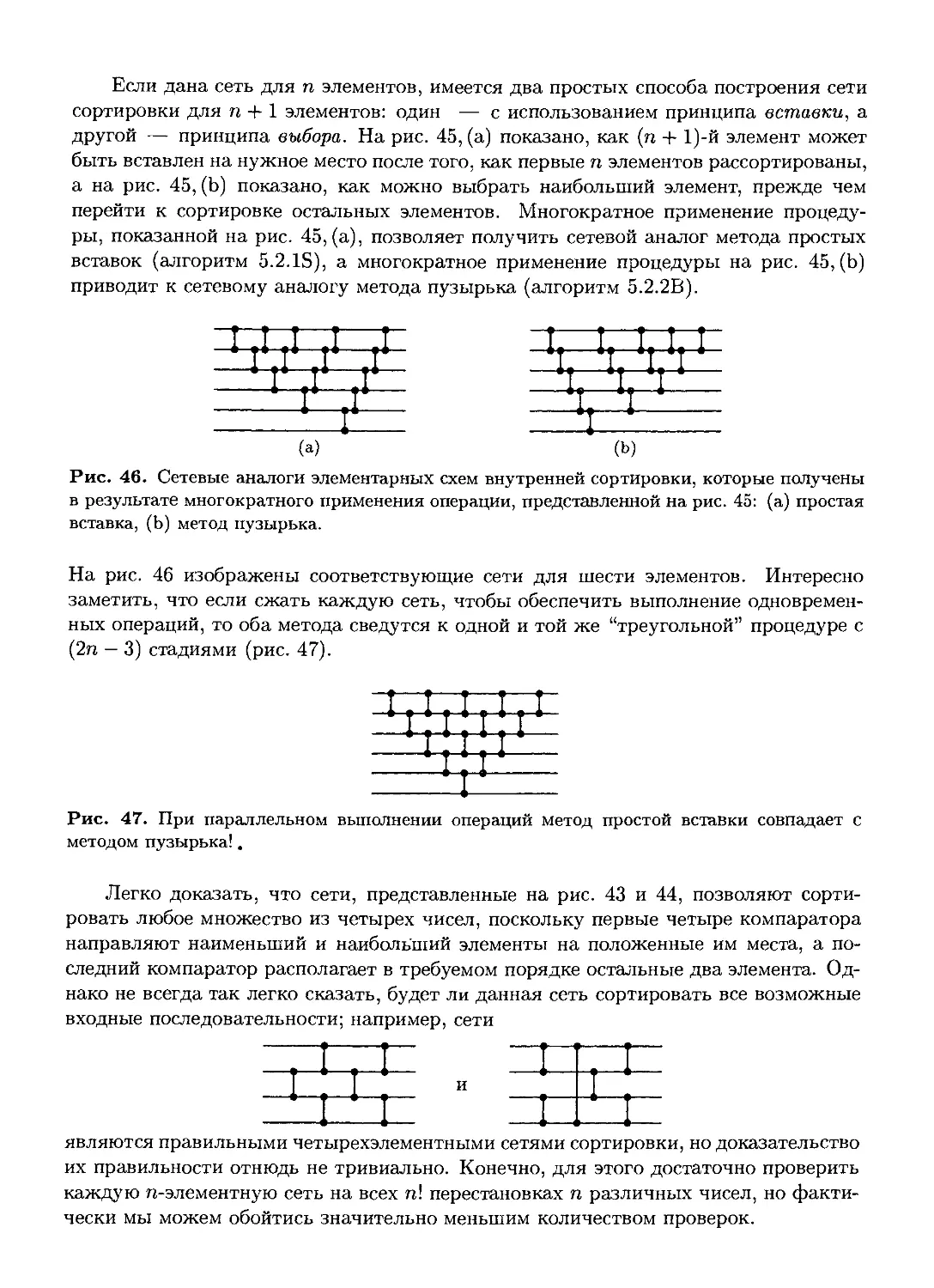

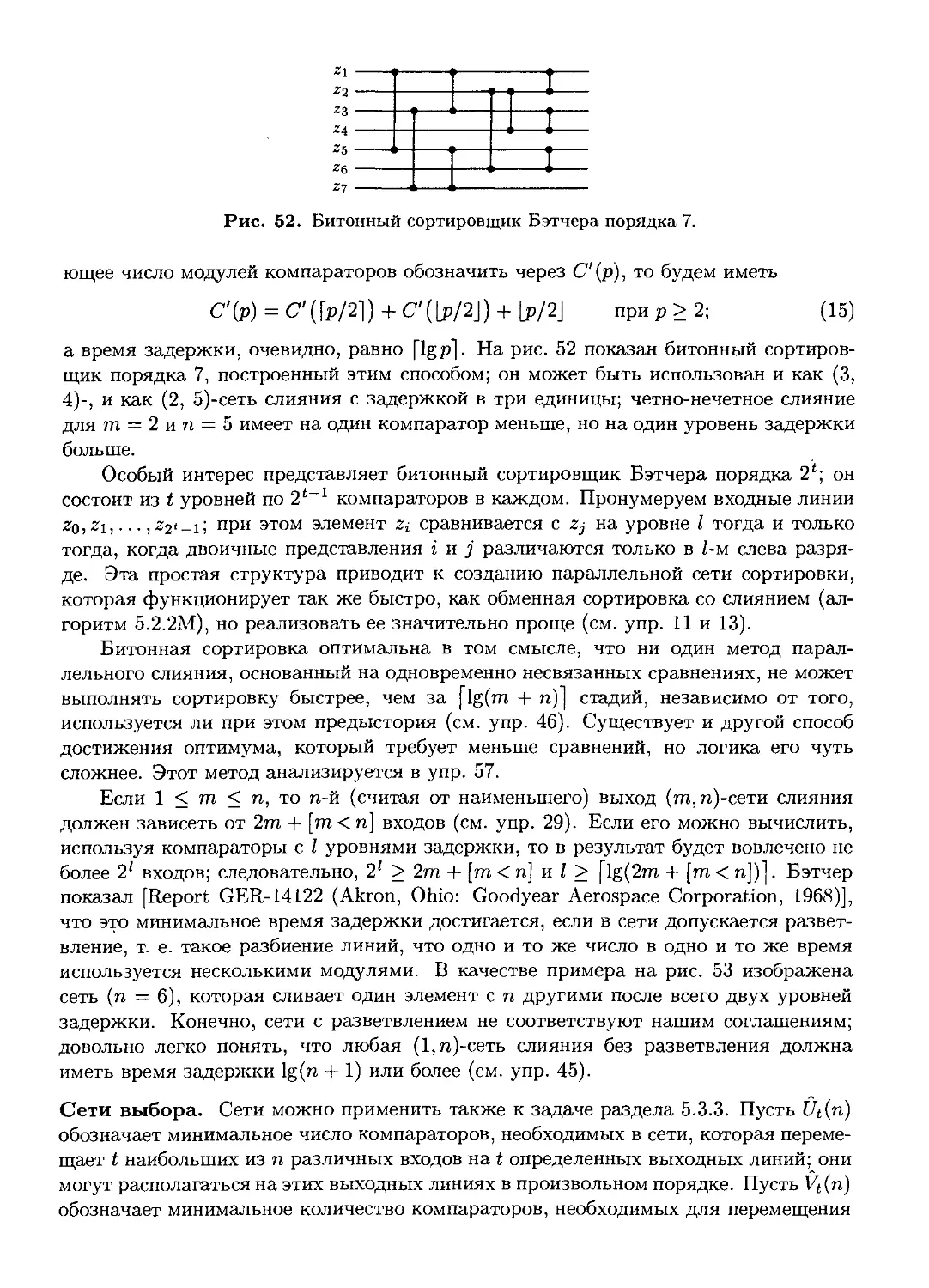

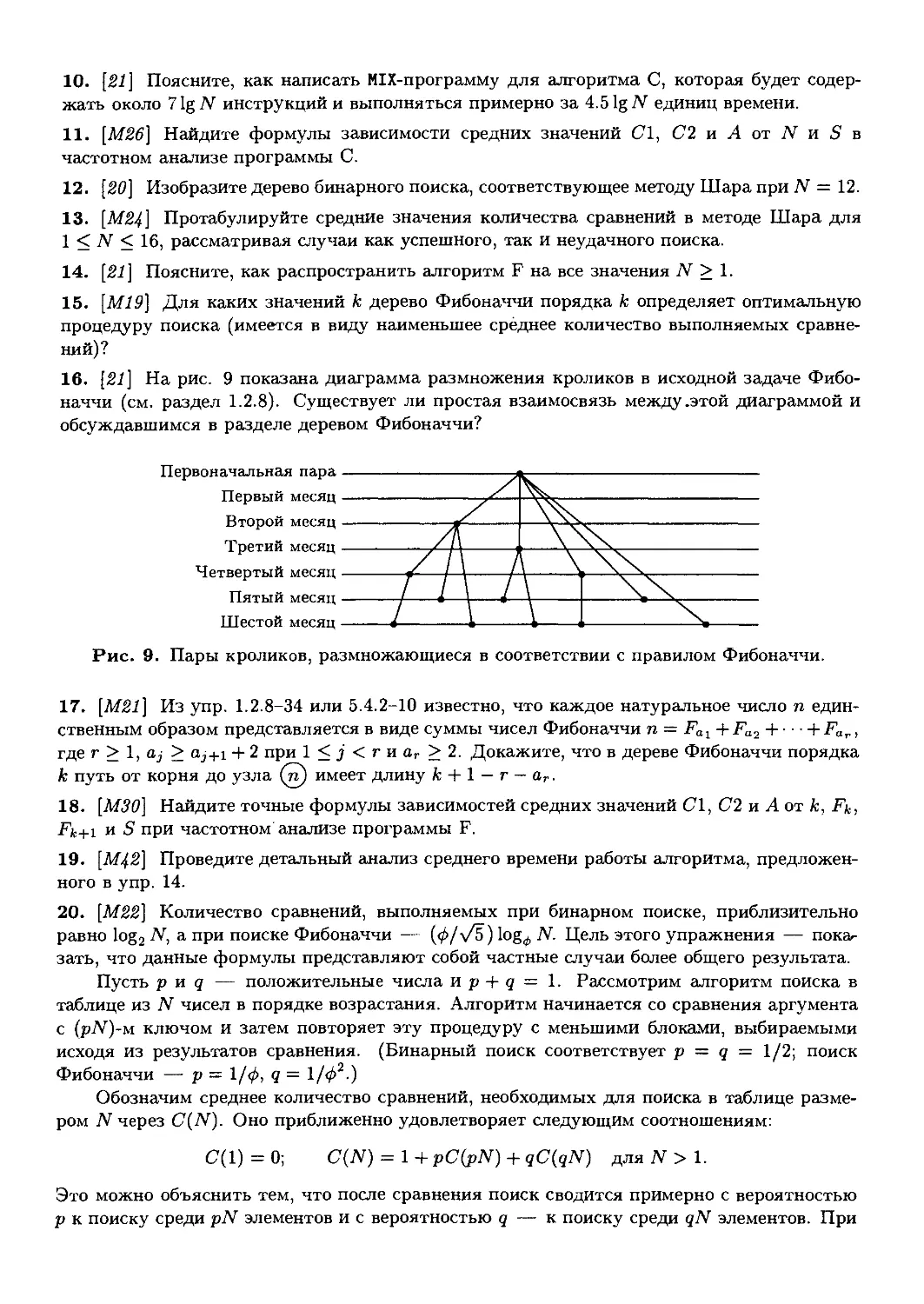

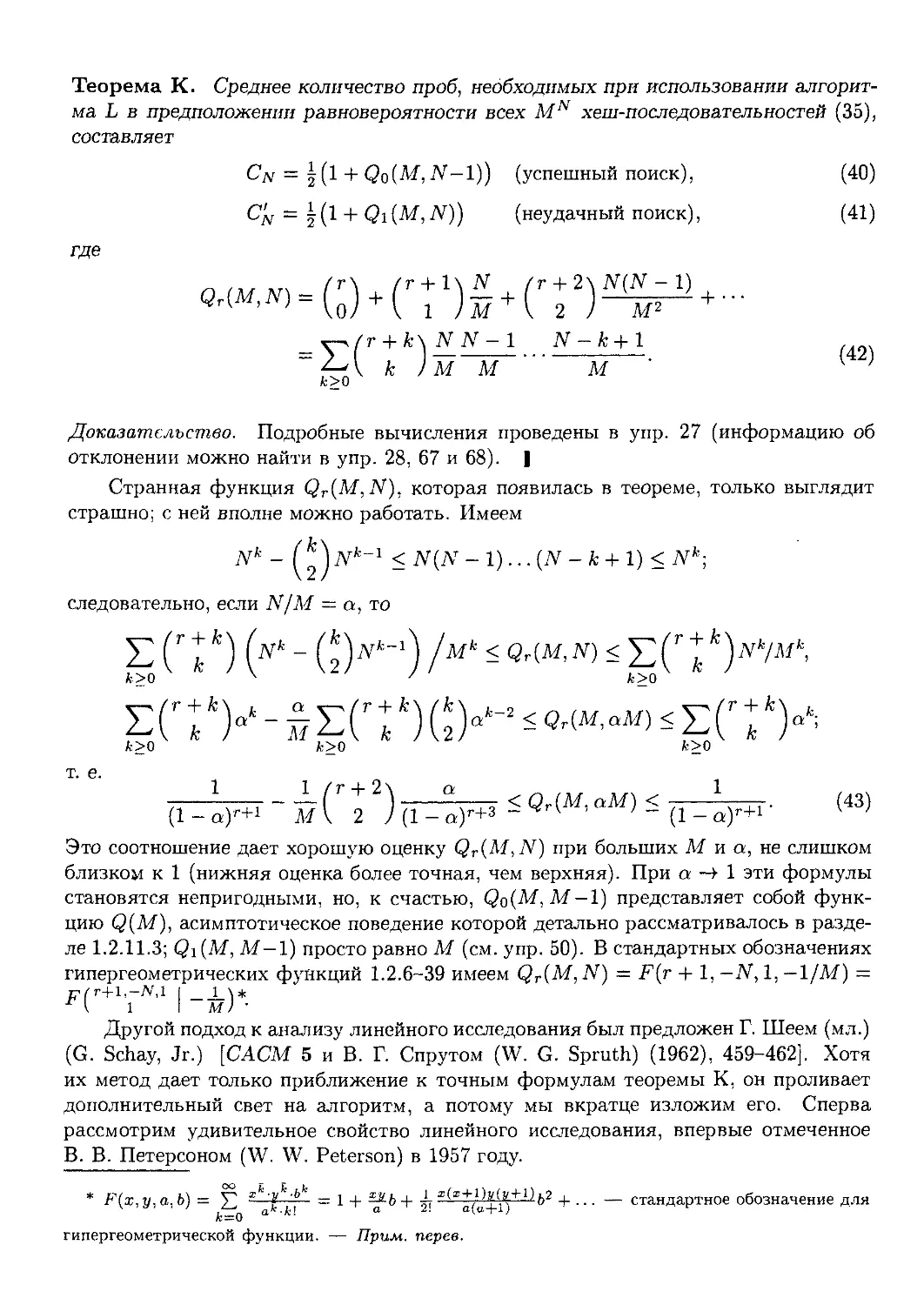

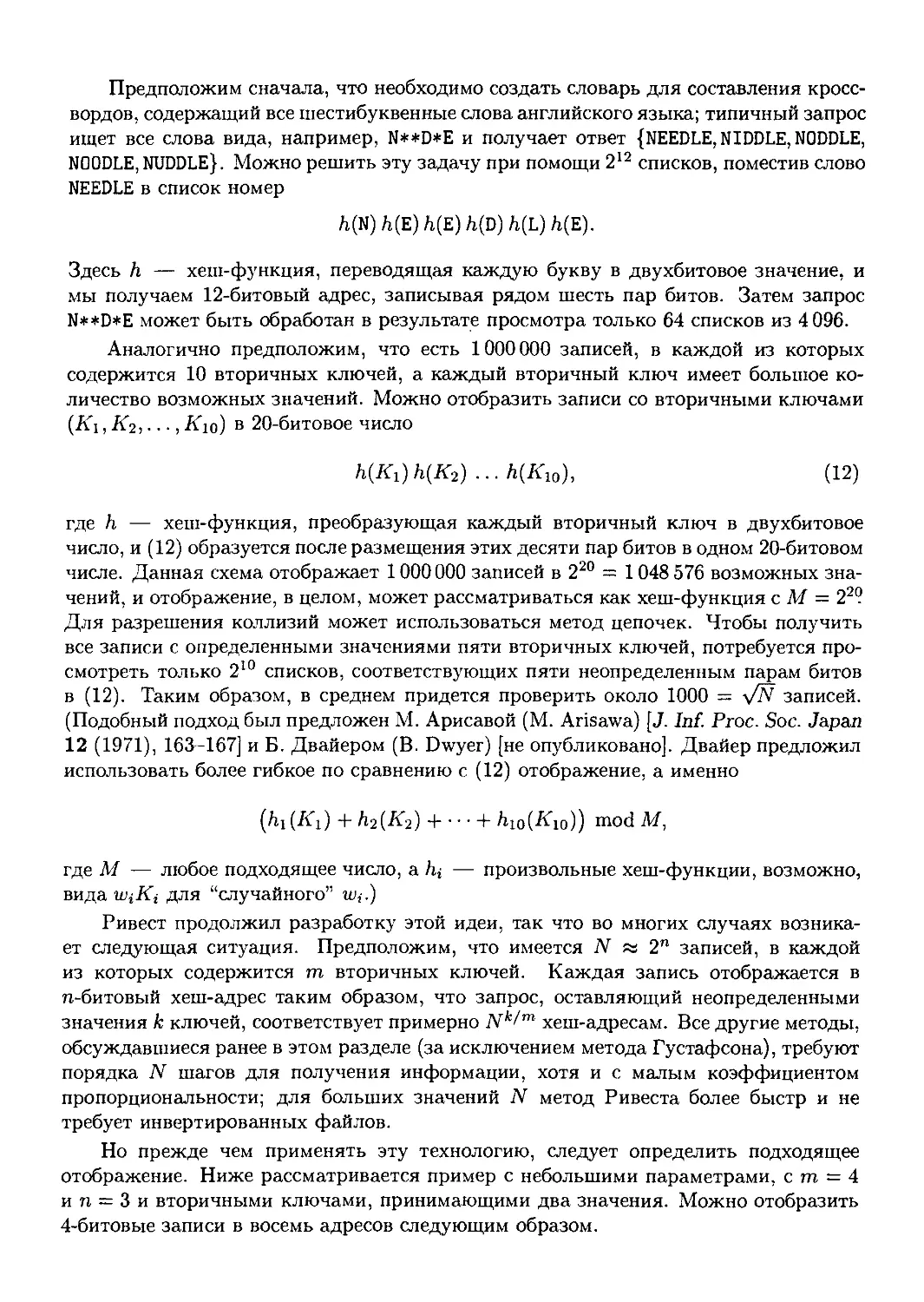

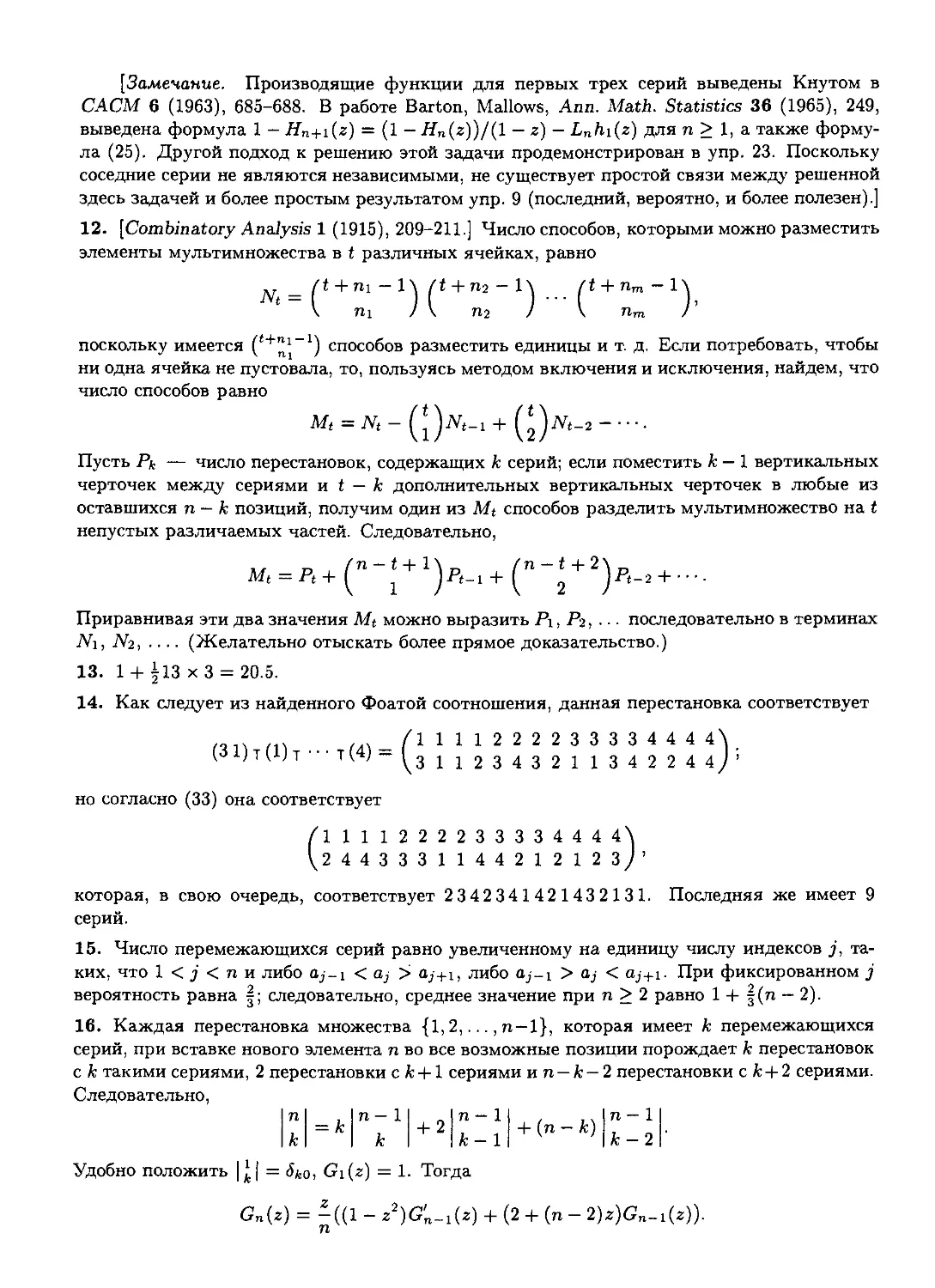

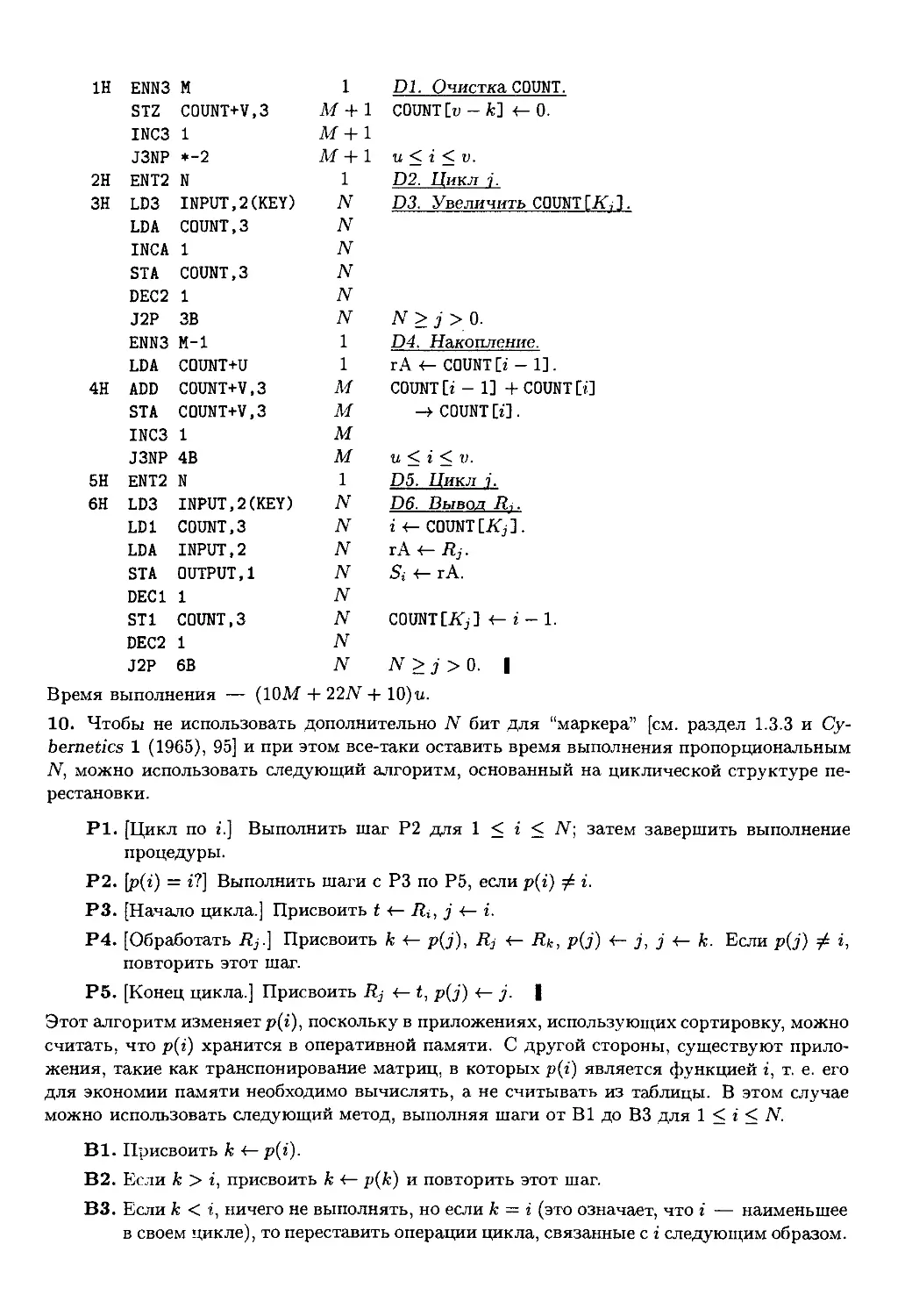

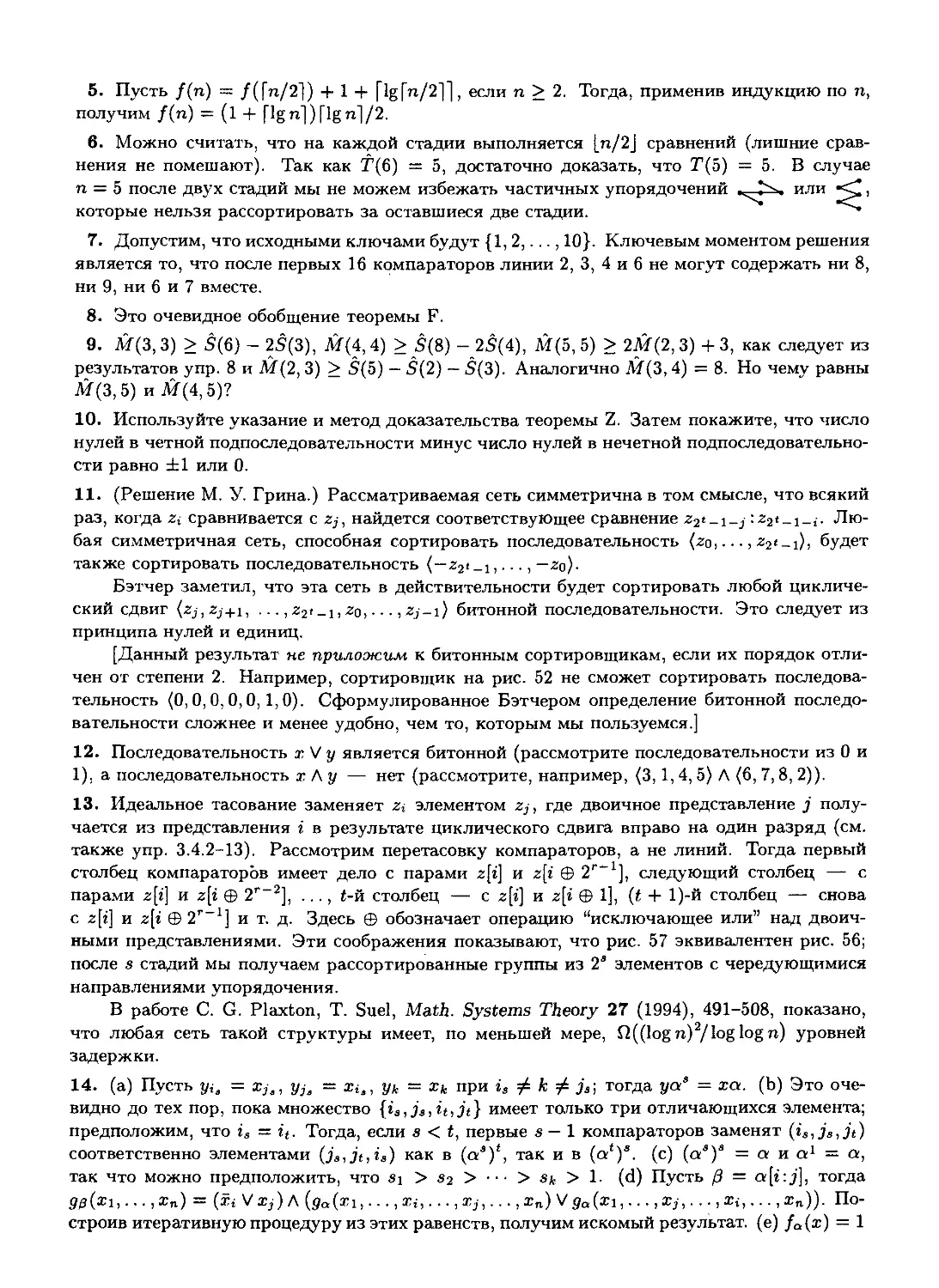

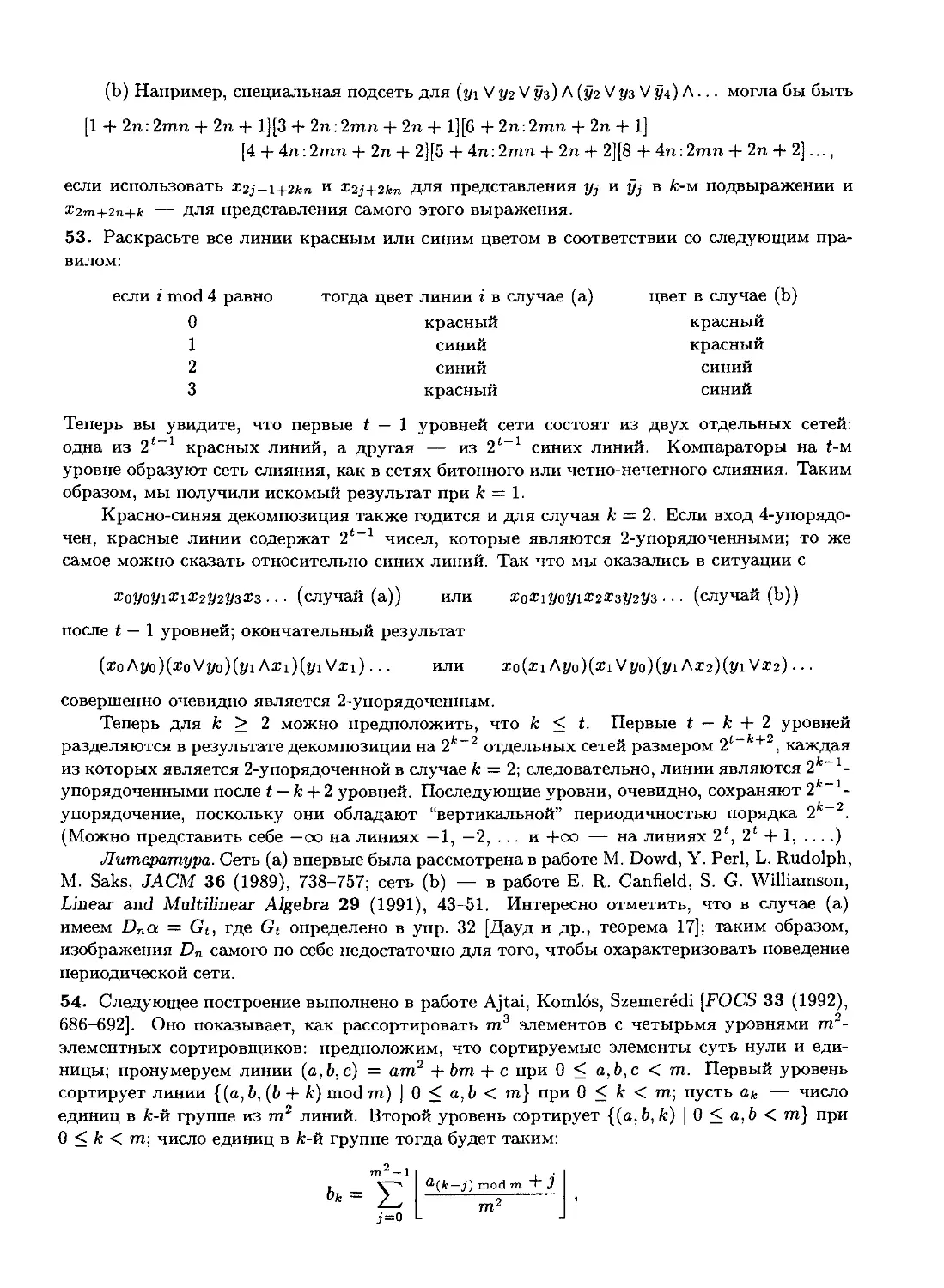

Рис. 1. Усеченный октаэдр, на котором показано изменение числа инверсий, когда меня-

меняются местами два соседних элемента перестановки.

I

n n — 1

1 + - = #„.

Аналогичным способом легко получить и соответствующую производящую функ-

функцию.

Ясно, что если поменять местами соседние элементы перестановки, то общее

число инверсий увеличится или уменьшится на единицу. На рис. 1 показаны 24

перестановки множества {1,2,3,4}; линиями соединены перестановки, отличающи-

отличающиеся одна от другой положением двух соседних элементов; двигаясь вдоль линии

вниз, мы увеличиваем число инверсий на единицу. Следовательно, число инверсий

в перестановке п равно длине нисходящего пути из 1234 в ж на рис. 1; все такие пути

должны иметь одинаковую длину.

Заметим, что эту диаграмму можно рассматривать как трехмерное твердое

тело — "усеченный октаэдр" имеющий 8 шестиугольных и 6 квадратных граней.

Это один из классических правильных многогранников, которые исследовал еще

Архимед (см. упр. 10).

Не следует путать "инверсии" перестановок (inversions of a permutation) с обрат-

обратными перестановками (inverse of a permutation). Вспомним, что перестановку мож-

можно записывать в виде двух строк:

2 3

а2 а3

п

а„

D)

Обратной называется перестановка а[ а'2 а'3 ... а'п, которая получается, если в D)

поменять местами строки, а затем упорядочить столбцы в порядке возрастания по

верхним элементам:

1

аз

3

E)

1X

Например, обратной к перестановке 591826473 будет перестановка 359716842,

так как

'591826473\/123456789Ч

123456 789/ ~ 1 359 7 1 6842

Можно дать другое определение обратной перестановки: a'j = к тогда и только

тогда, когда ак — j.

Понятие обратной перестановки впервые ввел X. А. Роте (Н. A. Rothe) [в Samm-

lung combinatorisch-analytischerAbhandlungen, edited by К. F. Hindenburg, 2 (Leipzig,

1800), 263-305]. Он заметил интересную связь между обратными перестановками

и инверсиями: обратная перестановка содержит ровно столько инверсии, сколько

исходная. Роте дал не самое простое доказательство этого факта, но оно поучи-

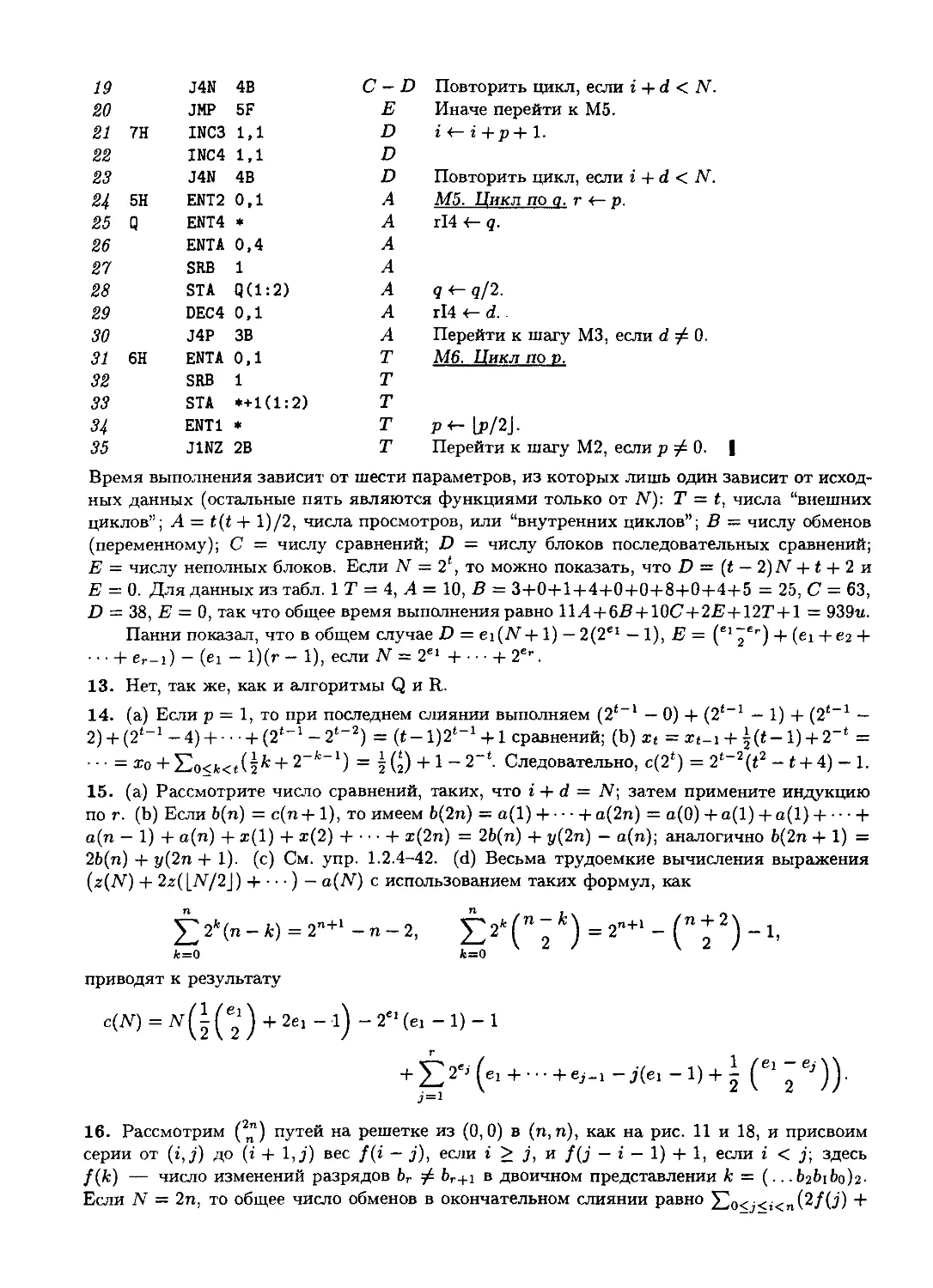

поучительно и притом довольно красиво. Построим таблицу размером n x п, наподобие

шахматной доски, в которой точки стоят в j-й клетке г'-й строки, если а* = j. После

этого расставим крестики во всех клетках, снизу от которых (в том же столбце) и

справа (в той же строке) есть точки. Например, для 591826473 диаграмма будет

выглядеть следующим образом:

X

X

•

X

X

X

•

X

X

X

X

X

X

•

X

X

X

X

•

•

X

X

•

X

X

•

X

•

•

Количество крестиков равно числу инверсий, так как нетрудно видеть, что bj равно

числу крестиков в j-м столбце. Если мы теперь транспонируем диаграмму (поменяв

ролями строки и столбцы), то получим диаграмму для обратной по отношению к

исходной перестановки; значит, число крестиков (число инверсий) одинаково в обоих

случаях. Роте использовал данный факт для доказательства того, что детерминант

матрицы не меняется при транспонировании.

Для анализа некоторых алгоритмов сортировки необходимо знать число пере-

перестановок п элементов, содержащих ровно к инверсий. Обозначим это число через

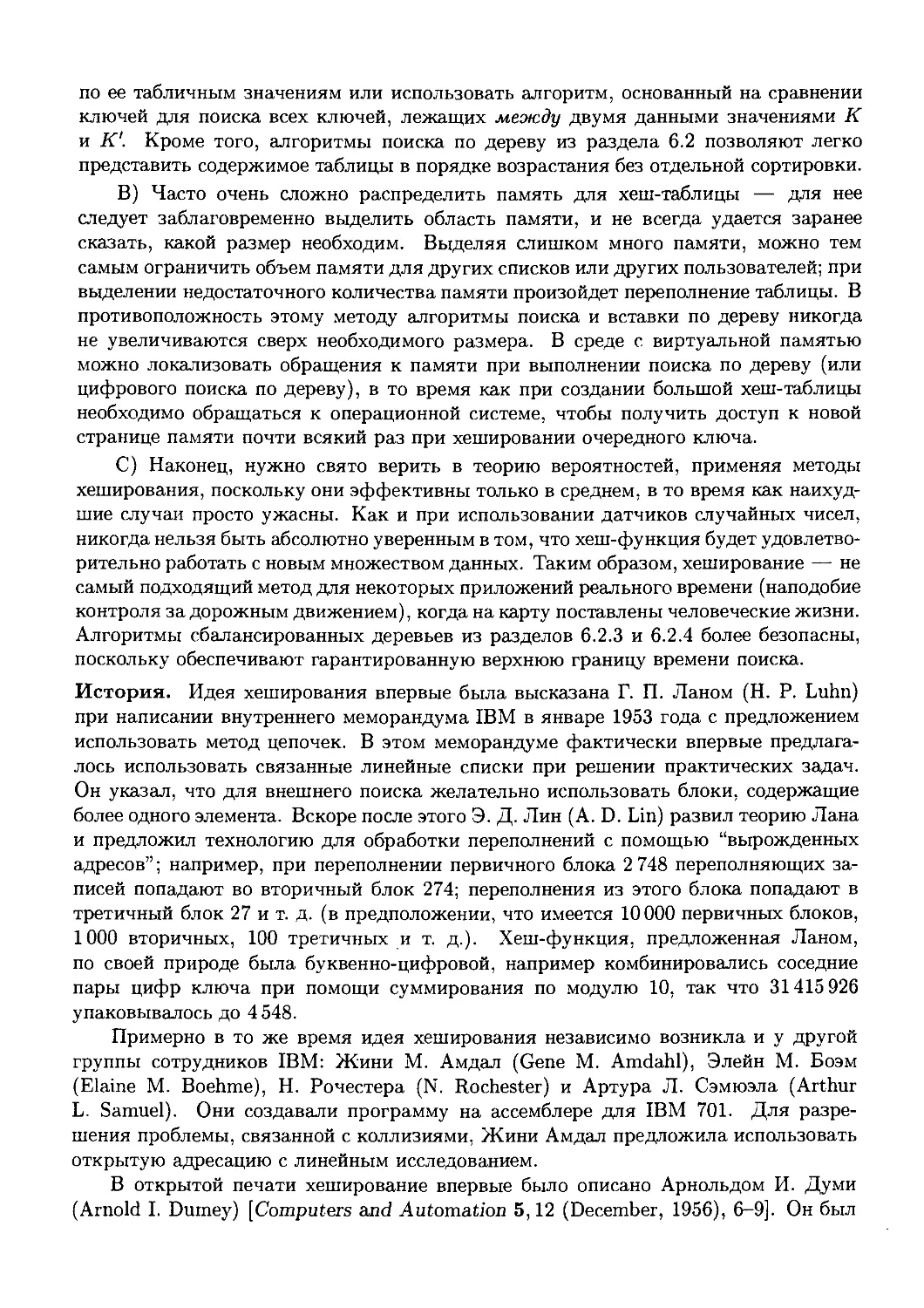

1п(к): в табл. 1 приведено несколько первых значений данной функции.

Из таблицы инверсий bib-2---bn ясно, что /„@) = 1, /пA) = п — 1 и что

выполняется свойство симметрии:

1п((П2)-к)=1п(к).

F)

Далее, так как значения bk можно выбирать независимо одно от другого, нетрудно

видеть, что производящая функция

Gn(z) = 7„@) + In(l)z + InB)z2 + ¦¦¦ G)

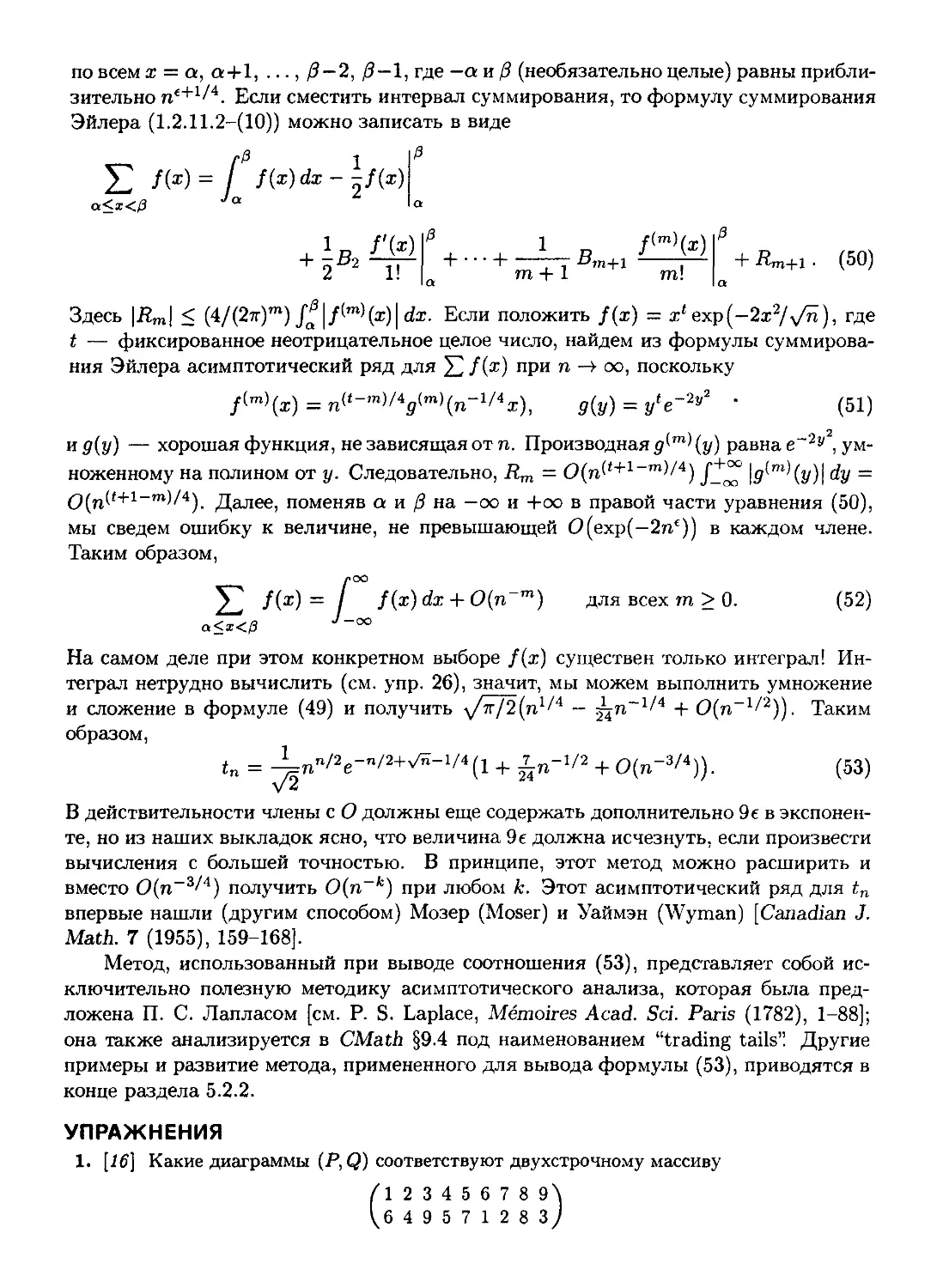

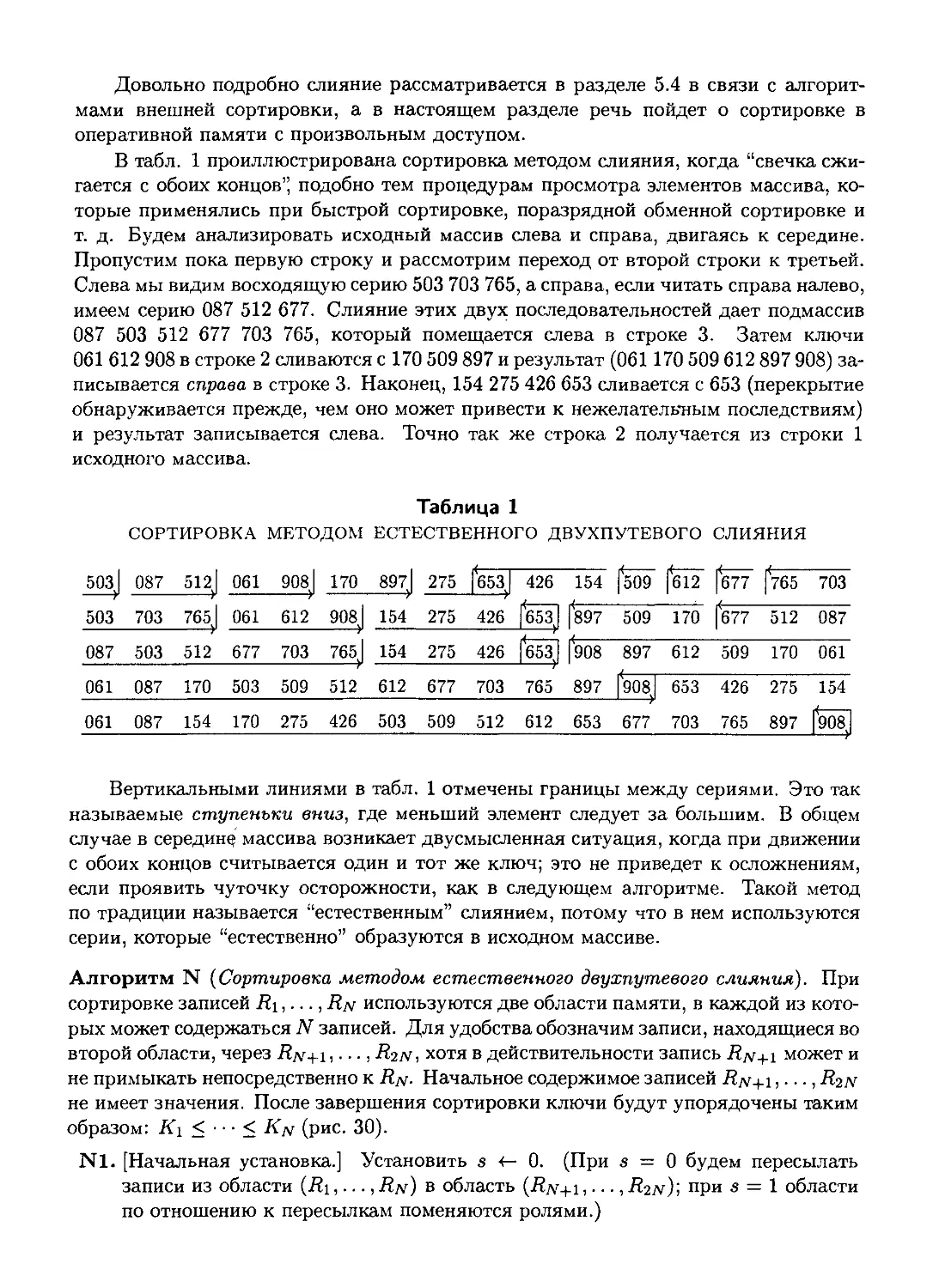

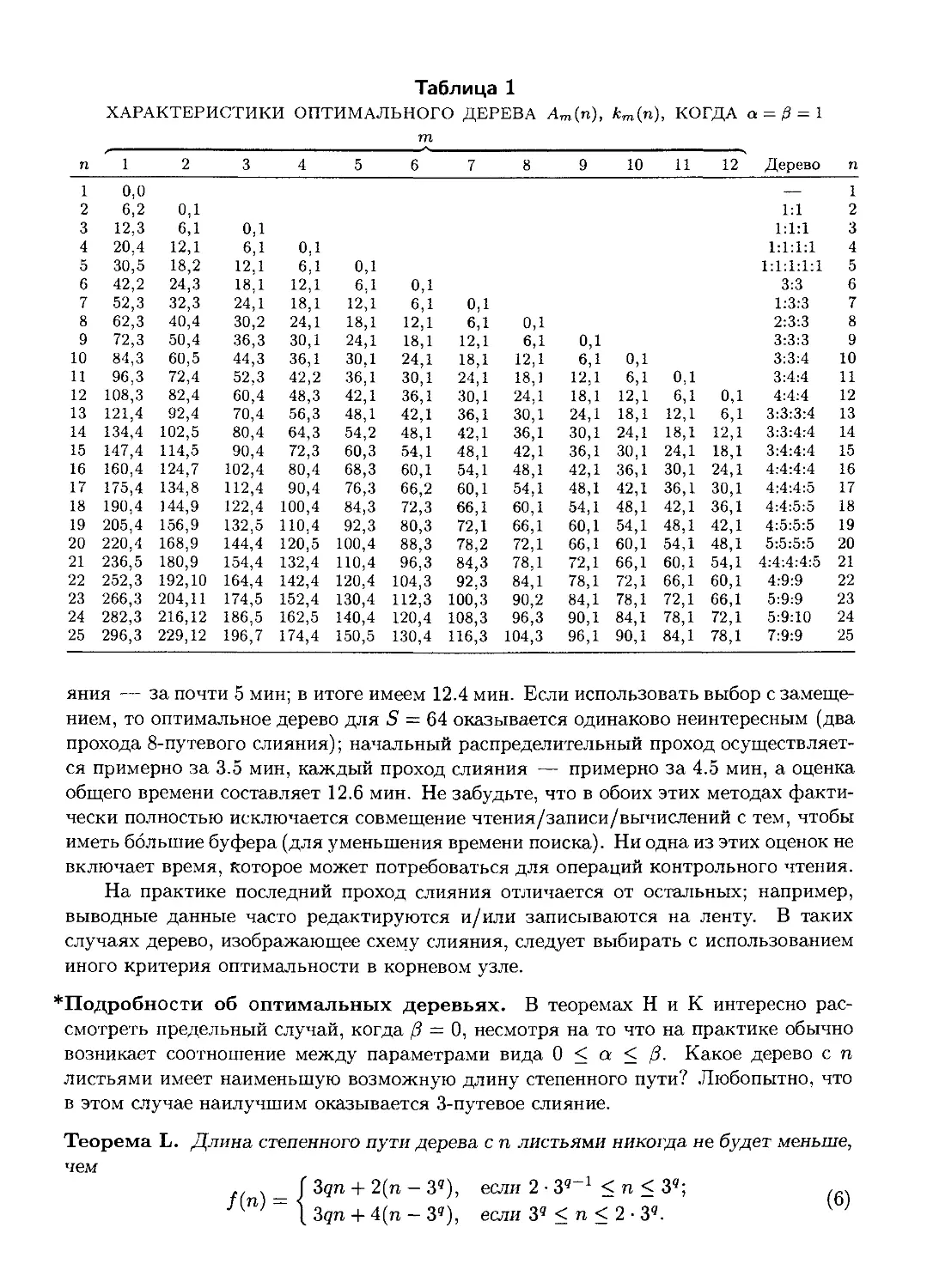

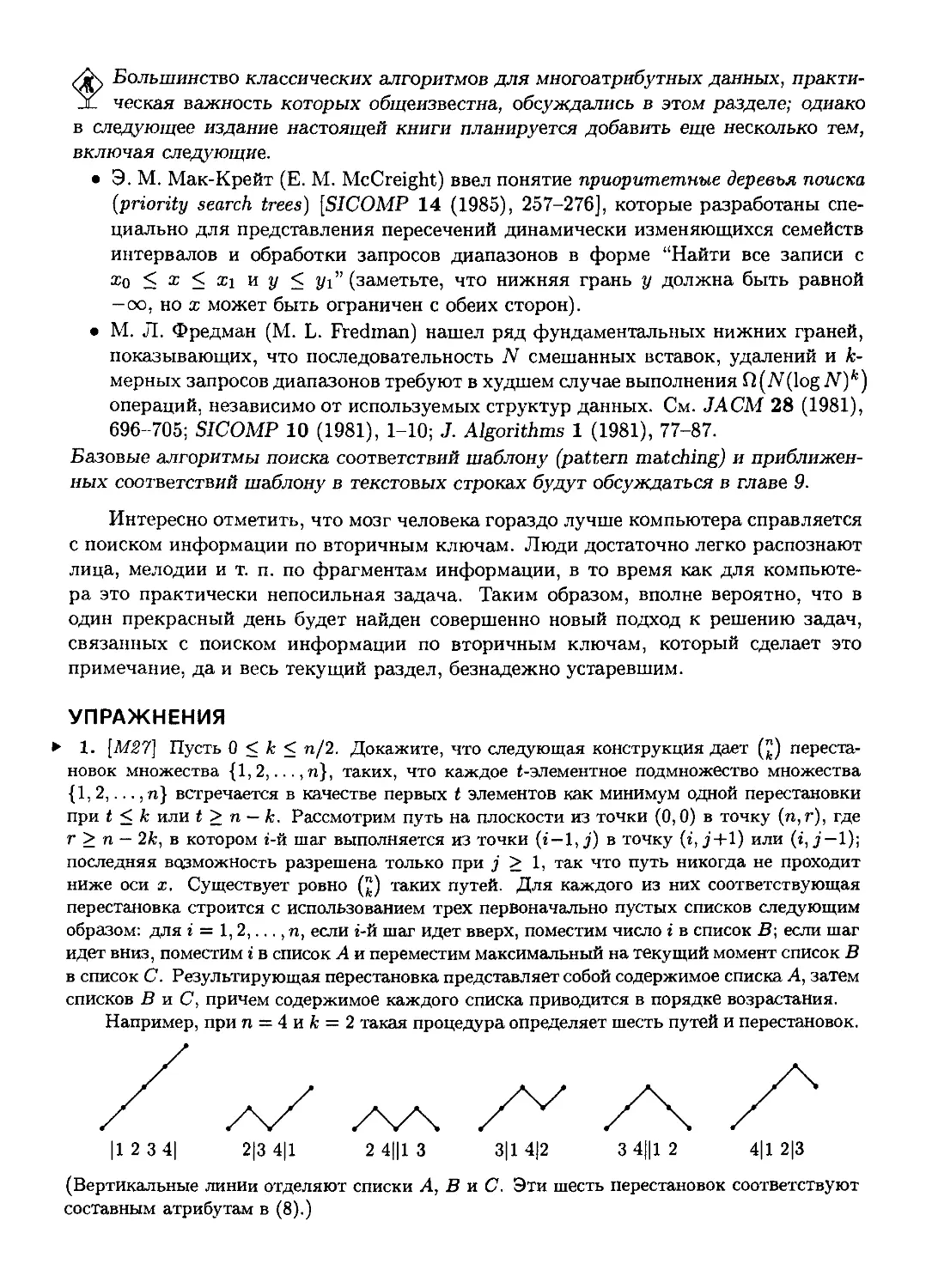

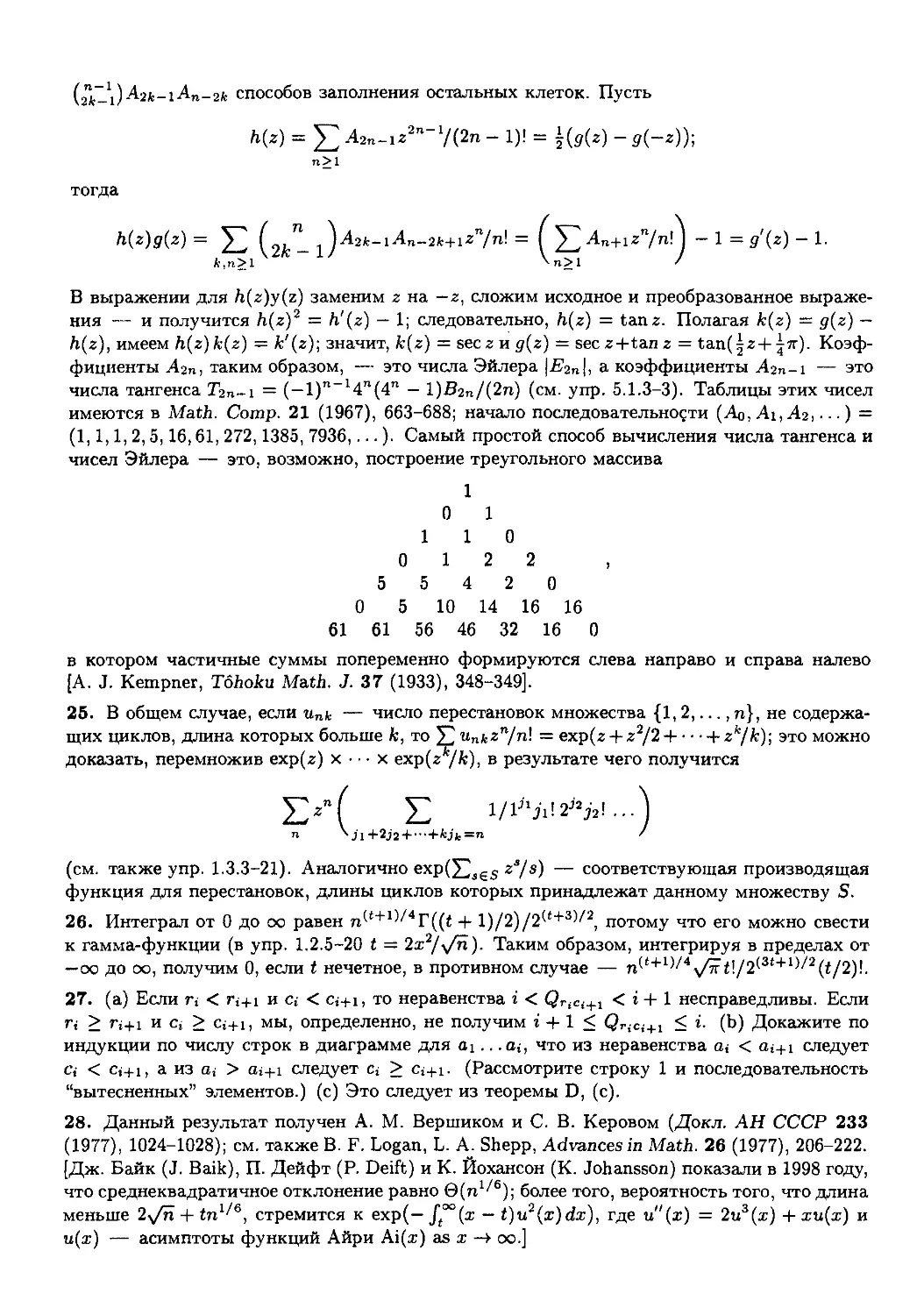

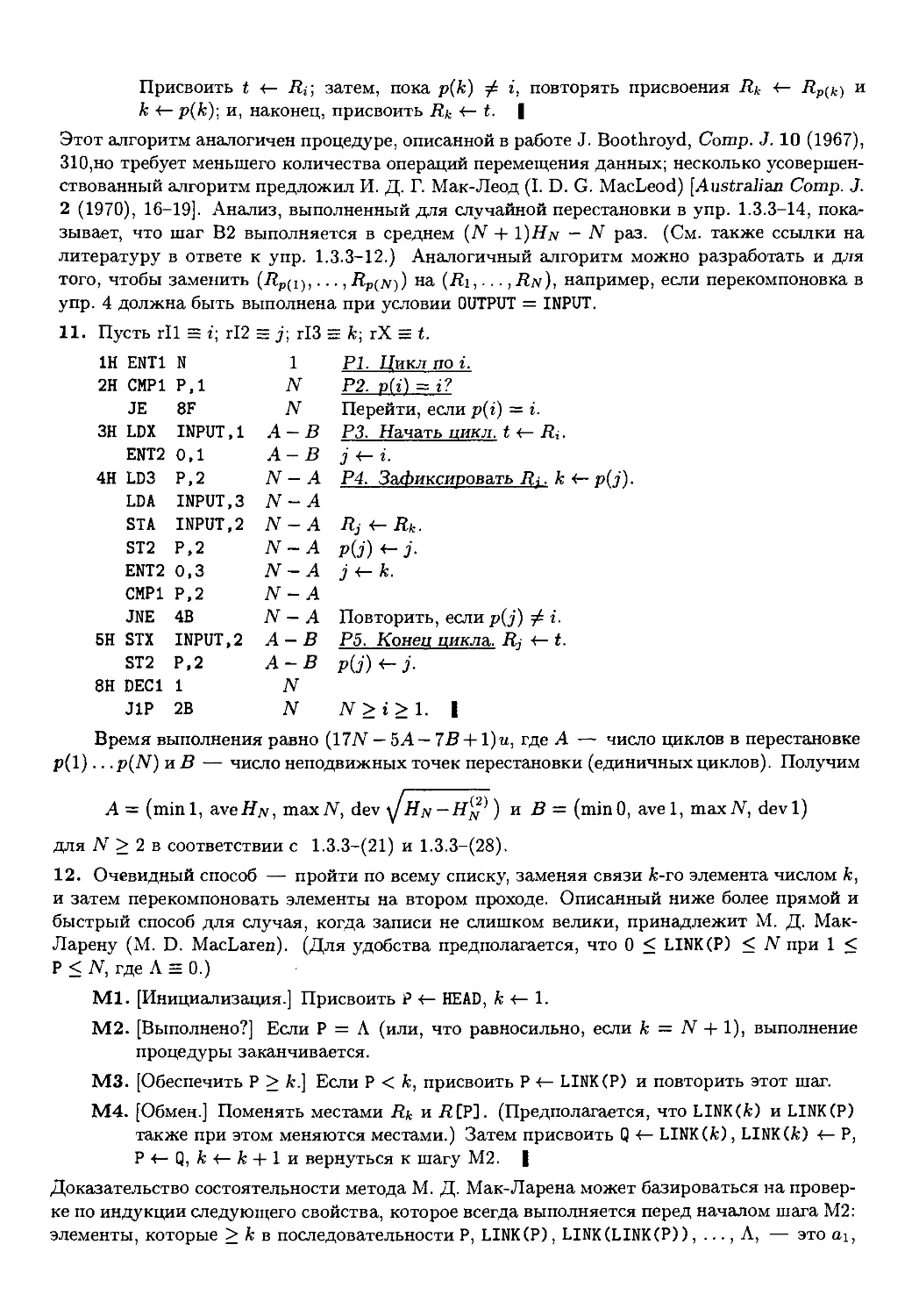

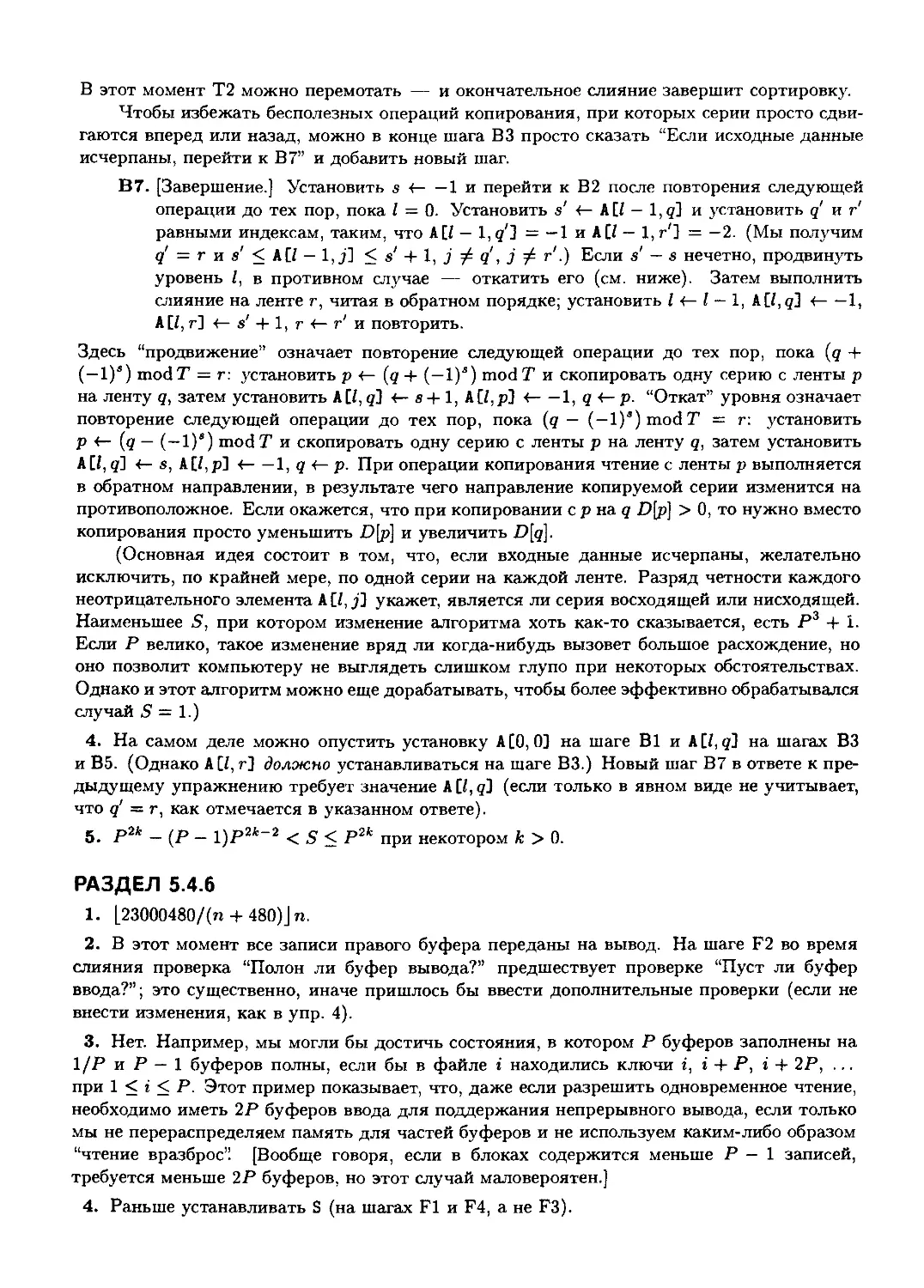

Таблица 1

ПЕРЕСТАНОВКА С к ИНВЕРСИЯМИ

n

1

2

3

4

5

6

/»@)

1

1

1

1

1

1

/»A)

0

1

2

3

4

5

/»B)

0

0

2

5

9

14

/»C)

0

0

1

6

15

29

/»D)

0

0

0

5

20

49

/»E)

0

0

0

3

22

71

/»F)

0

0

0

1

20

90

/»G)

0

0

0

0

15

101

/»(8)

0

0

0

0

9

101

/»(9)

0

0

0

0

4

90

/„A0)

0

0

0

0

1

71

/„A1)

0

0

0

0

0

49

удовлетворяет соотношению Gn(z) = A + z + ¦¦¦ + zn 1)Gn-i(z); следовательно,

она имеет довольно простой вид, как показано О. Родригесом (О. Rodrigues) [J. de

Math. 4 A839), 236-240]:

A + z + ¦ ¦ ¦ + z"-1)... A + z)(l) = A - zn)... A - z2)(l - z)/(l - z)n. (8)

С помощью этой производящей функции можно легко продолжить табл. 1 и убедить-

убедиться, что числа, расположенные под ступенчатой линией в таблице, удовлетворяют

соотношению

/„(*) =/п(*-1) + /„_х(*), где к<п. (9)

(Для чисел, находящихся над ступенчатой линией, это соотношение не выполня-

выполняется.) Более сложные рассуждения (см. упр. 14) показывают, что на самом деле

справедливы формулы

/„B) =

•<»>-("Г)-(?)•

п > 2;

п > 3;

Общая формула для 1п{к) содержит около 1.6%/ifc слагаемых:

'п + к-2\ fn + k-3\ . /n+fc-6\ /n + /c-8

(п+к-3

V к-2

к-г

(n + k-Uj-j-1

V k-Uj-j

+ •¦-, n>k, A0)

где Uj — Cj2 — j)/2 — так называемое "пентагональное число"

Разделив Gn(z) на п\, получим производящую функцию gn(z) распределения

вероятностей числа инверсий в случайной перестановке п элементов. Она равна

произведению

9n(z) = h1(z)ha(z)...hn(z), A1)

где /ifc(z) = A + z + ¦ ¦ ¦ + zk l)/k — производящая функция равномерного рас-

распределения случайной величины, принимающей целые неотрицательные значения,

меньшие к. Отсюда*

i) + теап(/?2) + ¦ • ¦ + mean(/in)

o + + + Ц =^

vax(pn) = var(/ii) + var(/i2) H + var(/in)

= о + \ + ¦•• + =^± ="B"+g"-". аз)

Таким образом, среднее число инверсий довольно велико — около \п2; стандартное

отклонение также весьма велико — около \пг12.

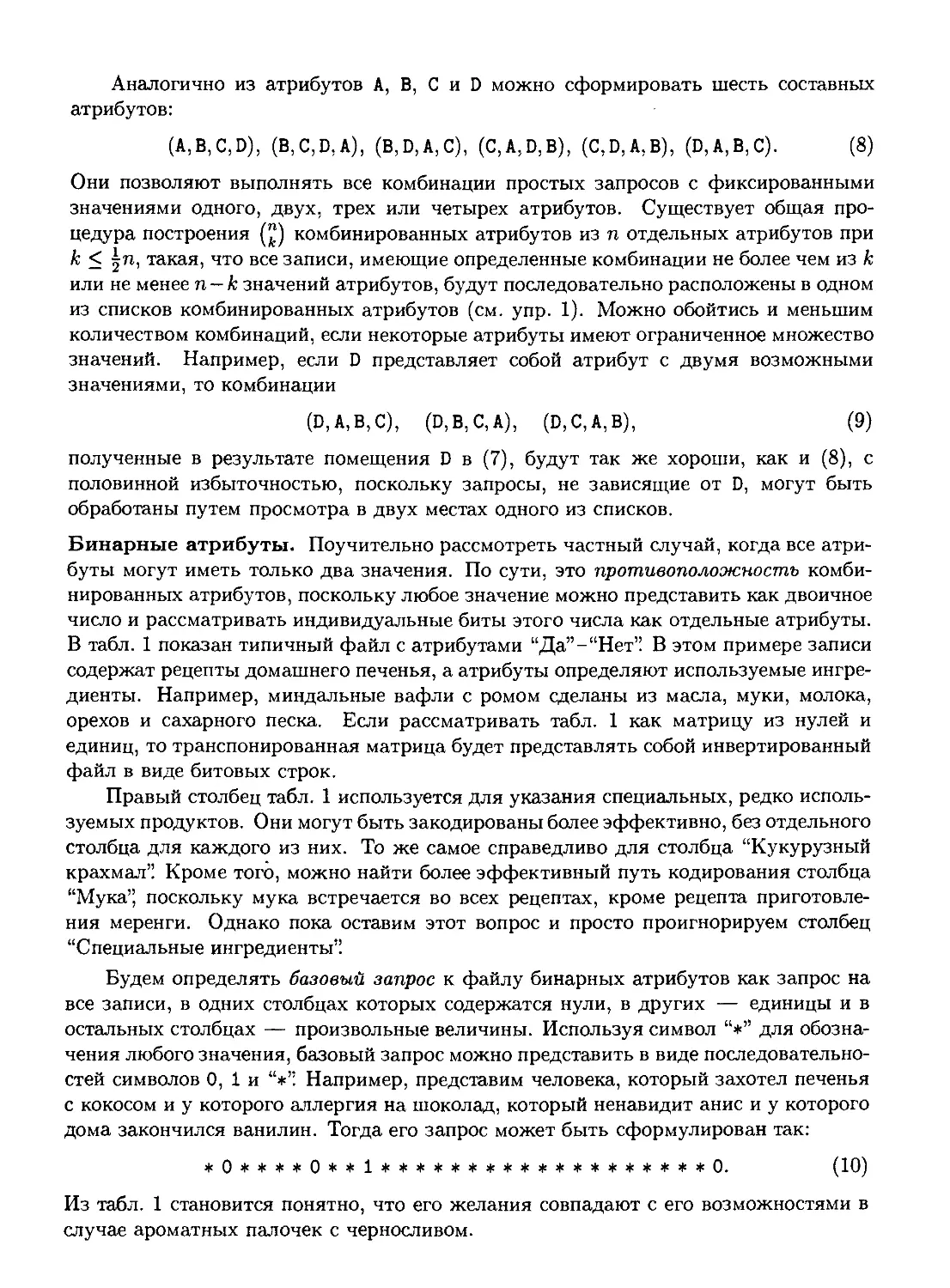

В качестве интересного завершения данной темы рассмотрим одно замечатель-

замечательное открытие, принадлежащее П. А. Мак-Магону (P. A. MacMahon) [Amer. J. Math.

35 A913), 281-322]. Определим индекс перестановки а\ а-2.. .ап как сумму всех j.

таких, что uj > a.j+\, 1 < j < п. Например, индекс перестановки 591826473равен

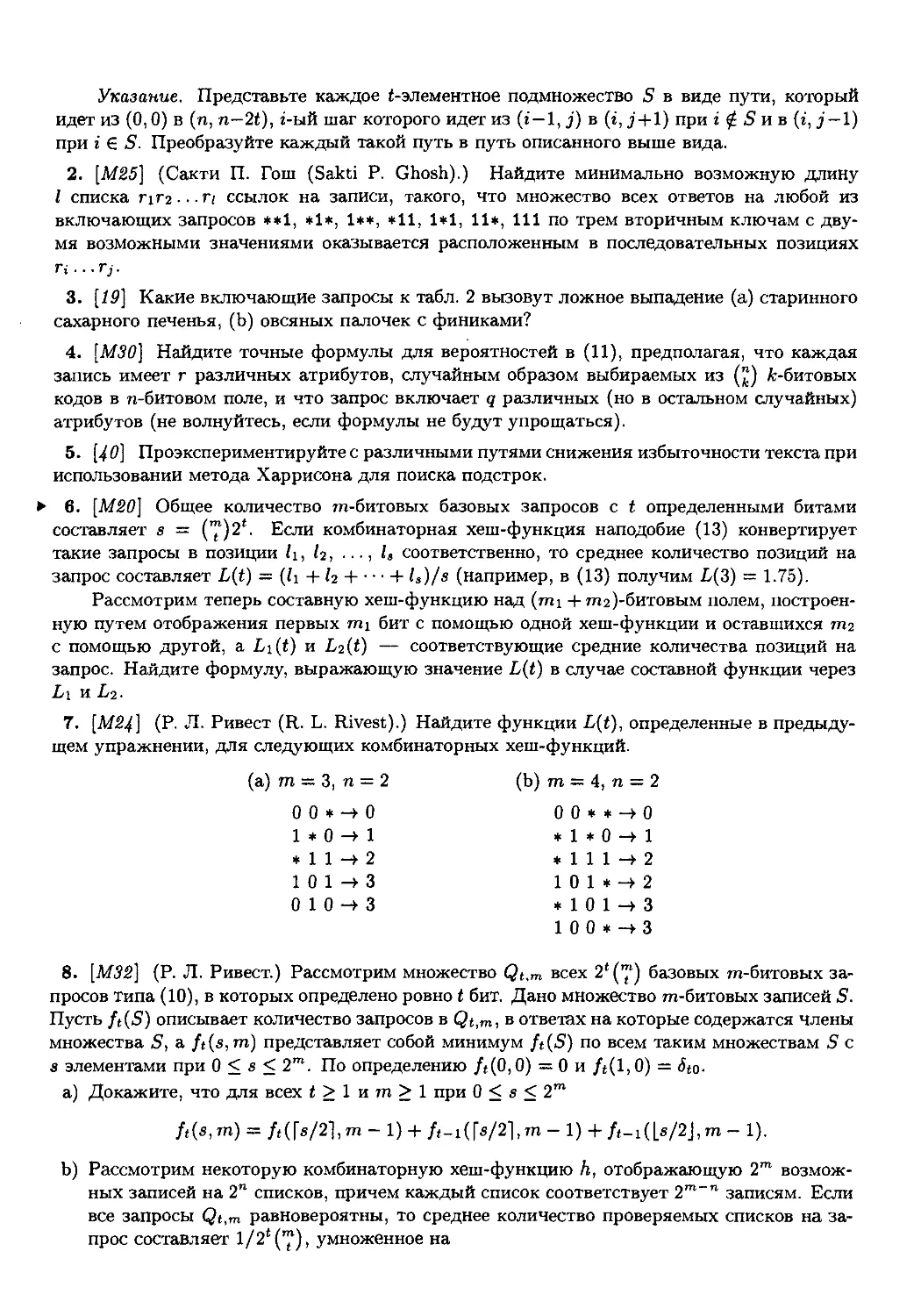

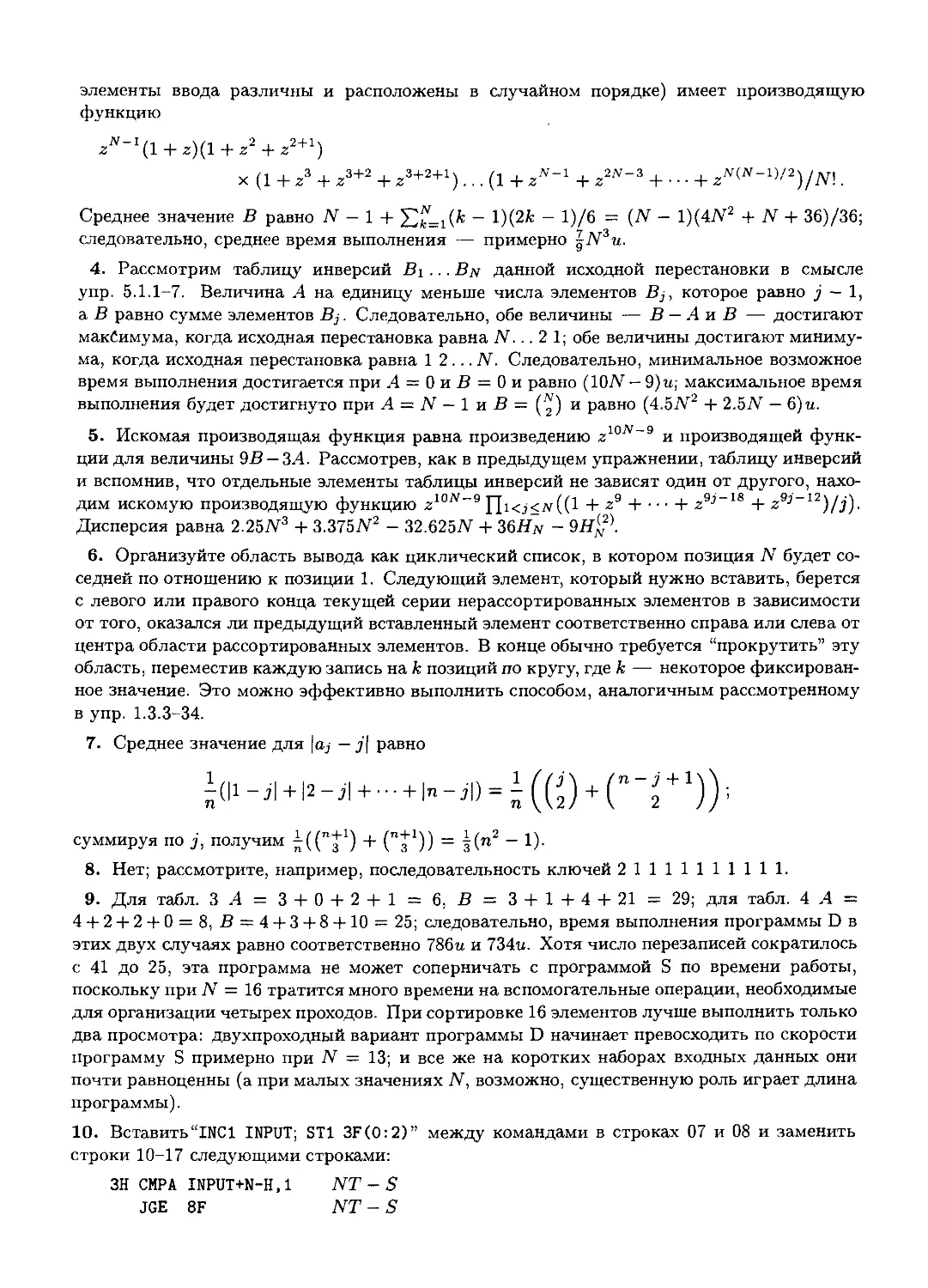

2 + 4 + 6 + 8 = 20. Индекс случайно совпал с числом инверсий. Если составить список

всех приведенных ниже 24 перестановок множества {1,2,3,4}, то получится, что

число перестановок, имеющих данный индекс к, равно числу перестановок, имеющих

к инверсий.

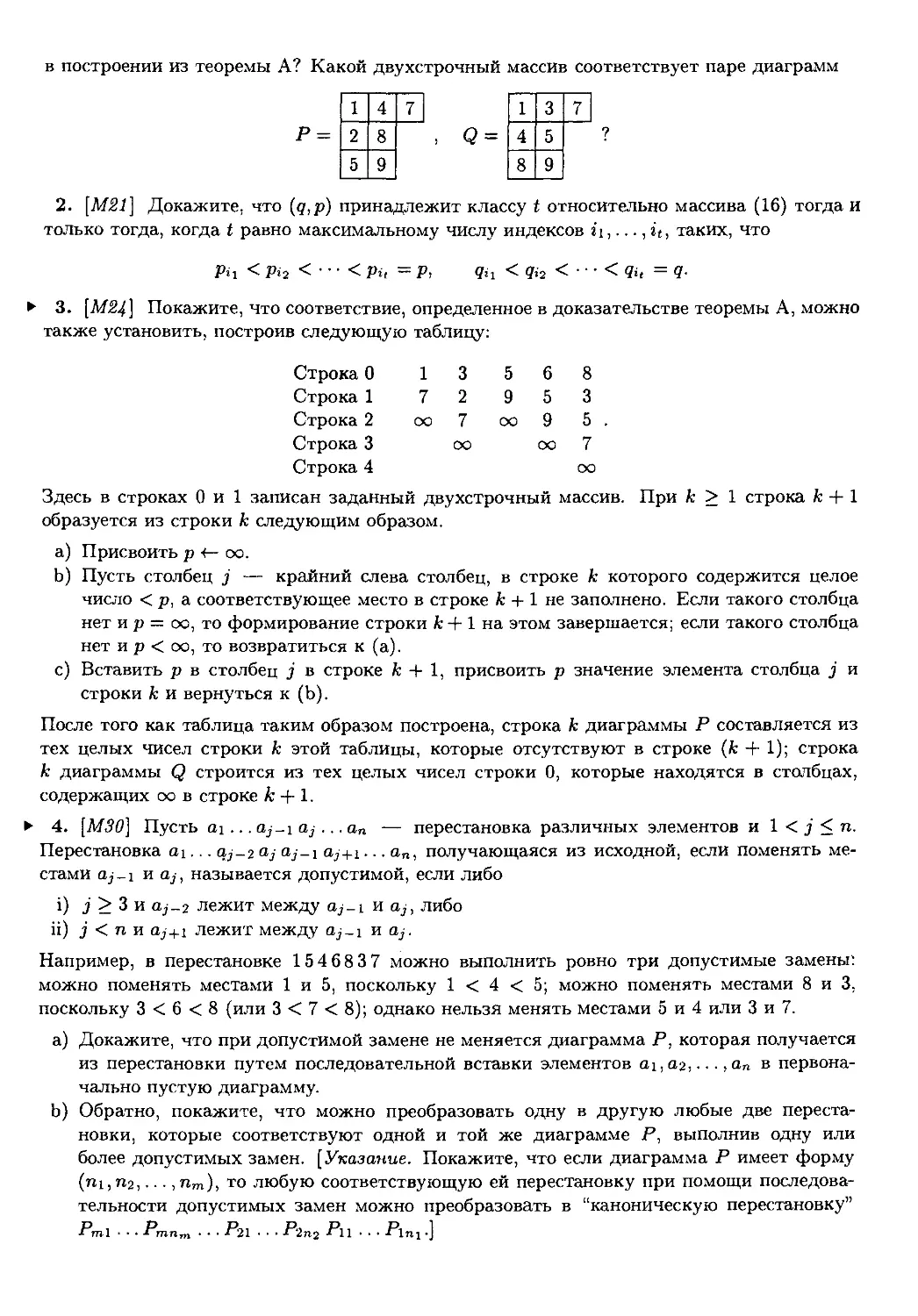

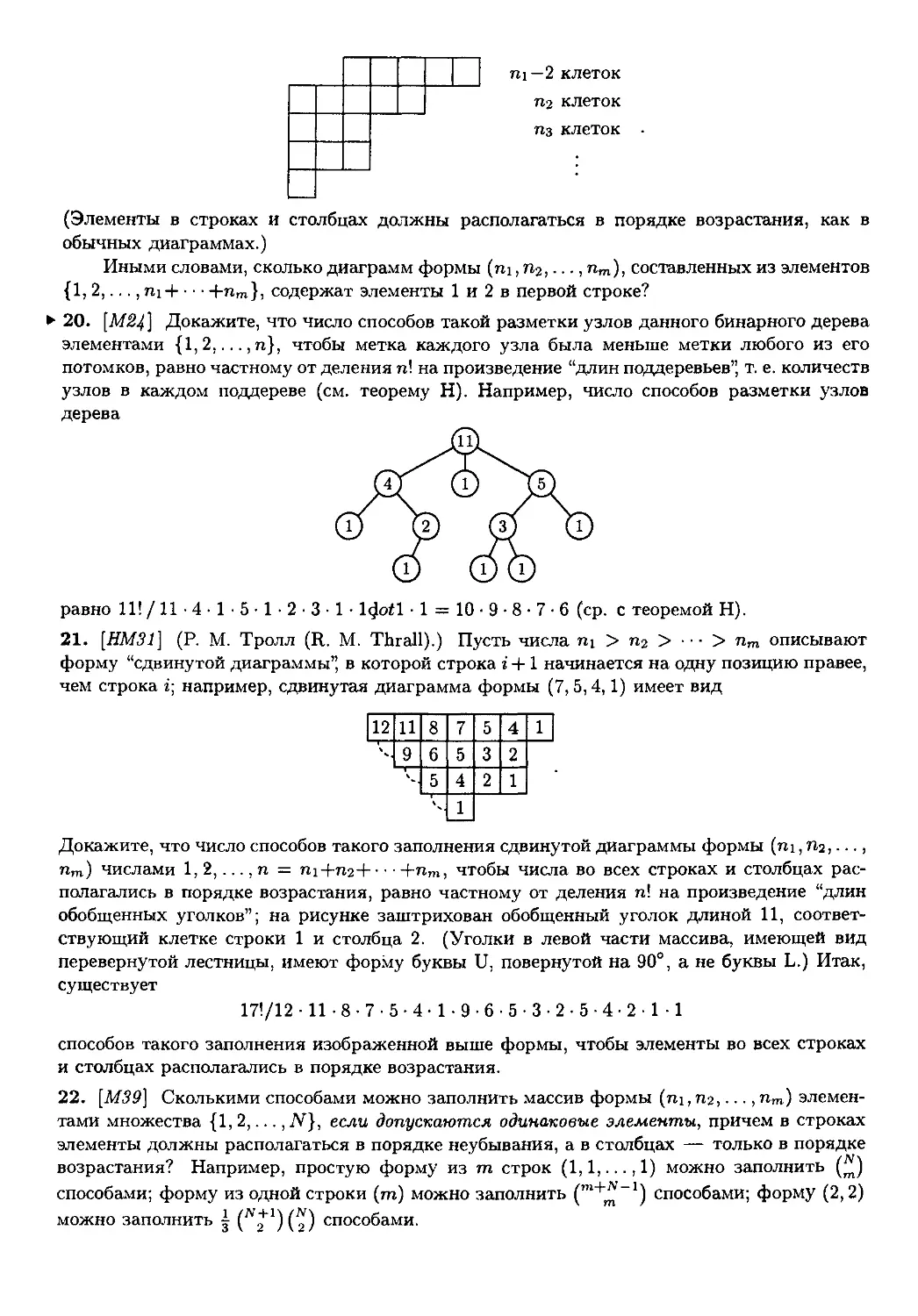

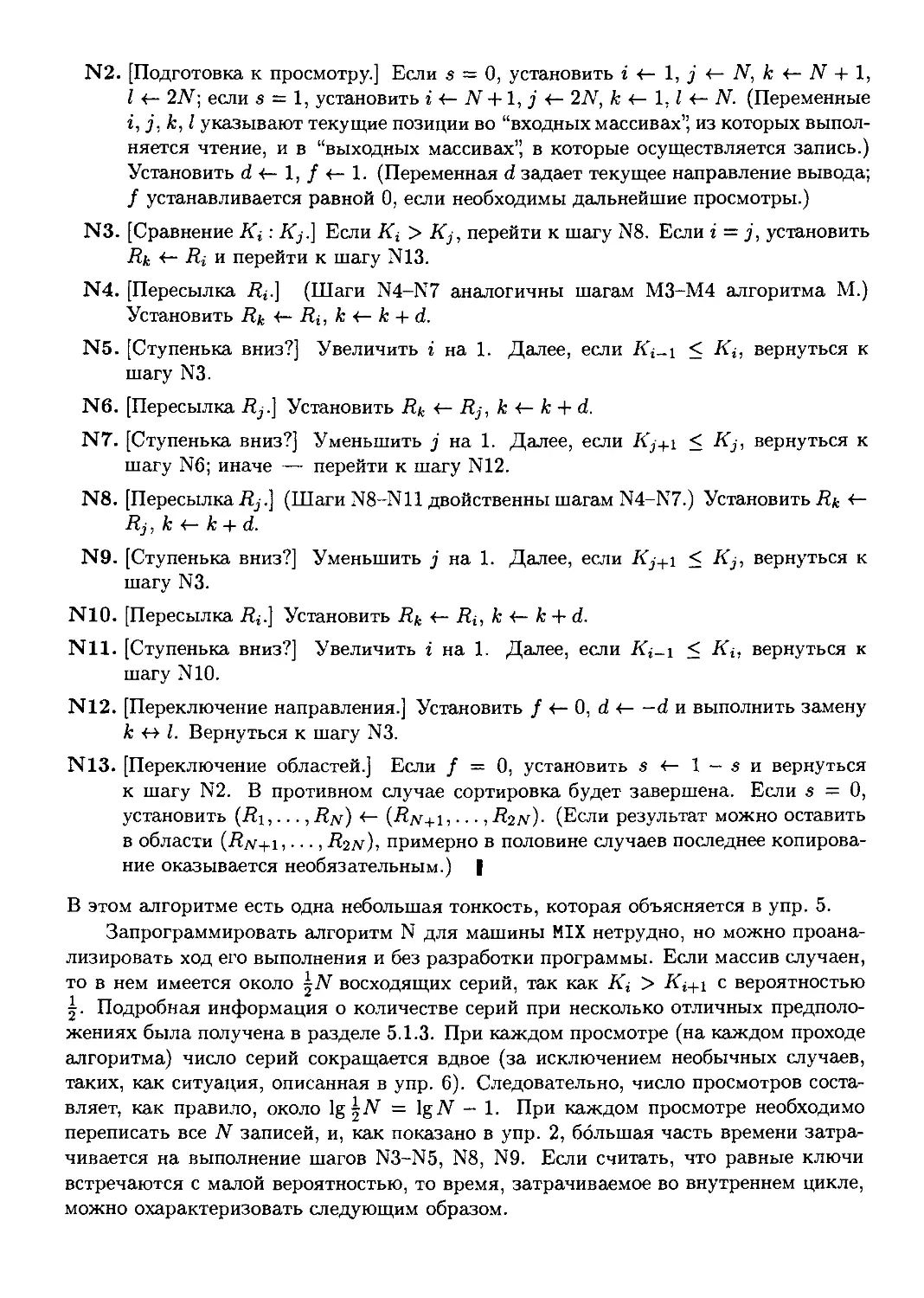

Перестановка

1234

1 2 4|3

13B 4

13 4|2

14|2 3

14|3|2

2|134

2|14|3

2 3|14

2 3 4|1

2 4|1 3

2 4 311

Индекс

0

3

2

3

2

5

1

4

2

3

2

5

Количество

инверсий

0

1

1

2

2

3

1

2

2

3

3

4

Перестановка

3|12 4

3|14|2

3|2|14

3|2 4|1

3 4|1 2

3 4|2|1

4|1 2 3

4|13|2

4|2|13

4|2 3|1

4|3|12

4131211

Индекс

1

4

3

4

2

5

1

4

3

4

3

6

Количество

инверсий

2

3

3

4

4

5

3

4

4

5

5

6

На первый взгляд, этот факт может показаться почти очевидным, однако после

некоторых размышлений он начинает казаться чуть ли не мистическим, и не видно

никакого простого прямого его доказательства. Мак-Магон нашел следующее остро-

остроумное косвенное доказательство. Пусть ind(aj a-i.. -an) — индекс перестановки

a.i a-2 ... an и соответствующая производящая функция есть

[nd(aia2-an\ A4)

* Здесь и далее mean(g) означает среднее значение случайной величины g, a var(#) — дисперсию

величины д. — Прим. перев.

где сумма в A4) берется по всем перестановкам множества {1,2,... ,п}. Требуется

доказать, что Hn(z) = Gn(z). Для этого определим взаимно однозначное соответ-

соответствие между n-мерными строками (qi,q-2, ¦¦¦ , 9п) неотрицательных целых чисел, с

одной стороны, и упорядоченными парами n-мерных строк

((а!, а2,..., а„), (pi ,р2, ¦ ¦ -,рп)),

с другой стороны, где а^ а2 ... а„ — суть перестановка множества индексов {1,2,...,

п} и Pi > Р2 > ¦ ¦ ¦ > Рп > 0. Это соответствие будет удовлетворять условию

q\ + Чг Л + Яп= ind(ai а2 ... ап) + {рх + р2 Н + р„). A5)

Производящая функция ^г'1"'2 '"'", где сумма берется по всем n-мерным стро-

строкам неотрицательных целых чисел (qx, q-i,..., qn), равна Qn{z) = 1/A — z)n; а про-

производящая функция ^zPl+P2 '"P", где сумма берется по всем n-мерным строкам

целых чисел (pi,p-2, ¦ ¦ ¦ ,Рп), таких, что р\ > р2 > • • • > рп > 0, равна

Pn(z) = 1/A -z)(l-z2)...(l-zn), A6)

как показано в упр. 15. Существование взаимно однозначного соответствия, кото-

которое удовлетворяет условию A5) и которое мы собираемся установить, доказывает

равенство Qn(z) = Hn(z)Pn(z), т. е.

Hn{z) = Qn(z)/Pn(z). A7)

Но Qn{z)/Pn(z) и есть Gn(z), как следует из (8).

Требуемое соответствие определяется с помощью простой процедуры сортиров-

сортировки. Любая n-мерная строка (qi,q-2, ¦ ¦ ¦ ,qn) может быть устойчиво реорганизована

в порядке невозрастания qni > qa2 > • • • > qan, где а\а2---ап — перестановка,

такая, что qaj = qaj+i и подразумевает aj < aj+i- Установим (pi,p2,- ¦ ¦ ,Рп) =

(?oi,?o2) • • -)?о„) и затем для 1 < j < п вычтем 1 из каждого р\, ..., pj для

таких j, которые соответствуют aj > aj+i. По-прежнему р\ > р2 > ¦¦• > рп,

поскольку pj обязательно превышает Pj+i, если только aj > a^+i- Полученная

в результате пара ((ai,a2,... ,an), (РъРг, • • • ,Рп)) удовлетворяет условию A5), по-

поскольку суммарное уменьшение элементов р равно ind(aj a2 ¦ ¦ .ап). Например, если

п = 9 и (qi,...,q9) - C,1,4,1,5,9,2,6,5), то получим аг...а9 = 685931724и

(pi,...,P9) = E,2,2,2,2,2,1,1,1).

Несложно вернуться к (qi, q2, ¦ ¦ ¦, qn), когда заданы aia2.. .ап и {рх, р2,..., р„)

(см. упр. 17). Итак, желаемое соответствие установлено, теорема Мак-Магона об

индексах доказана.

Д. Фоата (D. Foata) и М. П. Шуценберже (М. P. Schiitzenberger) отыскали неожи-

неожиданное расширение теоремы Мак-Магона через 65 лет после его первой публикации.

Число перестановок п элементов, которые имеют к инверсий и индекс I, равно числу

перестановок, которые имеют I инверсий п индекс к. Фактически Фоата и Шуцен-

Шуценберже нашли простое однозначное соответствие между перестановками первого и

второго типов (см. упр. 25).

УПРАЖНЕНИЯ

1. [10] Какова таблица инверсий для перестановки 2 71845936? Какой перестановке

соответствует таблица инверсий 5012120 0?

2. [M20] Классическая задача Иосифа формулируется следующим образом (см. также

упр. 1.3.2-22): п рабов вначале стоят по кругу; после того как m-го раба казнят, круг

смыкается, затем опять казнят m-ro раба и так до тех пор, пока всех рабов не постигнет

эта печальная участь. Таким образом, порядок, в котором рабы подвергаются наказанию,

представляет собой перестановку множества {1, 2,..., и). Например, если п = 8 и т = 4,

порядок будет иметь вид 54613872 (первым казнили 5-го раба и т. д.); таблица инверсий

для этой перестановки имеет вид 36310010.

Найдите простое рекуррентное соотношение для элементов bi b2 ... Ь„ таблицы инвер-

инверсий в общей задаче Иосифа для п рабов, если каждого m-ro раба казнят.

3. [18] Пусть перестановке а\ а2 ¦ • • ап соответствует таблица инверсий Ъ\ Ъ2 ... Ьп. Какой

перестановке oi а2 ... оп соответствует таблица инверсий

(п - 1 - 6i)(n - 2 - Ь2).. • (О - Ь„) ?

> 4. [20] Придумайте пригодный для компьютерной реализации алгоритм, который по

данной таблице инверсий Ь\Ь2...Ьп, удовлетворяющей условиям C), строил бы соответ-

соответствующую перестановку а\ а2 •. -ап- [Указание. Вспомните методы работы со связями в

памяти.]

5. [35] Для выполнения алгоритма из упр. 4 на типичном компьютере потребуется вре-

время, приблизительно пропорциональное n+bi + ¦ ¦ -+bn, а это в среднем равно 0(п2). Можно

ли создать алгоритм, порядок времени выполнения которого был бы существенно меньше,

чем п2?

> 6. [26] Придумайте алгоритм вычисления таблицы инверсий 6162-. Ь„, соответствую-

соответствующей данной перестановке ai а㦦 ¦ ап множества {1,2,... ,п}, время работы которого на

типичном компьютере было бы порядка п log п.

7. [20] Помимо таблицы fci 62 • •. bn, определенной в этом упражнении, можно определить

некоторые типы таблиц инверсий, соответствующих данной перестановке ai аг . ¦ ¦ an мно-

множества {1,2,... ,п}. В этом упражнении мы рассмотрим три других типа таблиц инверсий,

которые возникают в приложениях.

Пусть cj — число инверсий, первая компонента которых равна j, т. е. число эле-

элементов, меньших j и расположенных правее j. [Перестановке A) соответствует таблица

00014215 7; ясно, что 0 < с,< j] Пусть Bj = baj и Cj = caj.

Покажите, что при 1 < j < п справедливы неравенства 0 < Bj < j и 0 < Cj < n — j;

покажите также, что перестановку ai аг ... ап можно однозначно определить, если задана

таблица с\ сг -•. сп или В\ Вг ¦ ¦ • Вп, или С\ Сг ¦ • ¦ Сп-

8. [М2^] Сохраним обозначения, принятые в упр. 7. Пусть aia^-.-a^ — перестанов-

перестановка, обратная к ai аг • ¦. ап, и пусть соответствующие ей таблицы инверсий — Ь\ Ъ'2 ¦ ¦ ¦ Ь'п,

с[ с'2 ¦. ¦ с'п, В[ В'2 ... В'п и С[ С'2 ¦. ¦ С'„. Найдите как можно больше интересных соотношений

между числами Oj, bj, с,, Bj, Cj^a'j, b'j, с), B\, Cj.

> 9. [М21] Докажите, что в обозначениях, принятых в упр. 7, перестановка aia2-..an

представляет собой инволюцию (т. е. обратна самой себе) тогда и только тогда, когда bj =

Cj при 1 < j' < п.

10. [НМ20] Рассмотрите представленный на рис. 1 октаэдр как многогранник в трехмер-

трехмерном пространстве. Чему равен диаметр усеченного октаэдра (расстояние между вершина-

вершинами 1234 и 4321), если все ребра имеют единичную длину?

11. [М25] Если 7г = ai аг ¦ ¦ ¦ an представляет собой перестановку множества {1, 2,..., п},

то обозначим как

Е(п) = {(at, aj)\i< j, аг > a,j]

множество ее инверсий, а как

E(n) = {(ai,aj) \i>j, сц > aj}

множество ее "неинверсий"

a) Докажите, что Е(п) и Е(тг) транзитивны. (Множество S упорядоченных пар назы-

называется транзитивным, если для любых (а,Ь) и (Ь,с), принадлежащих S, пара (а,с)

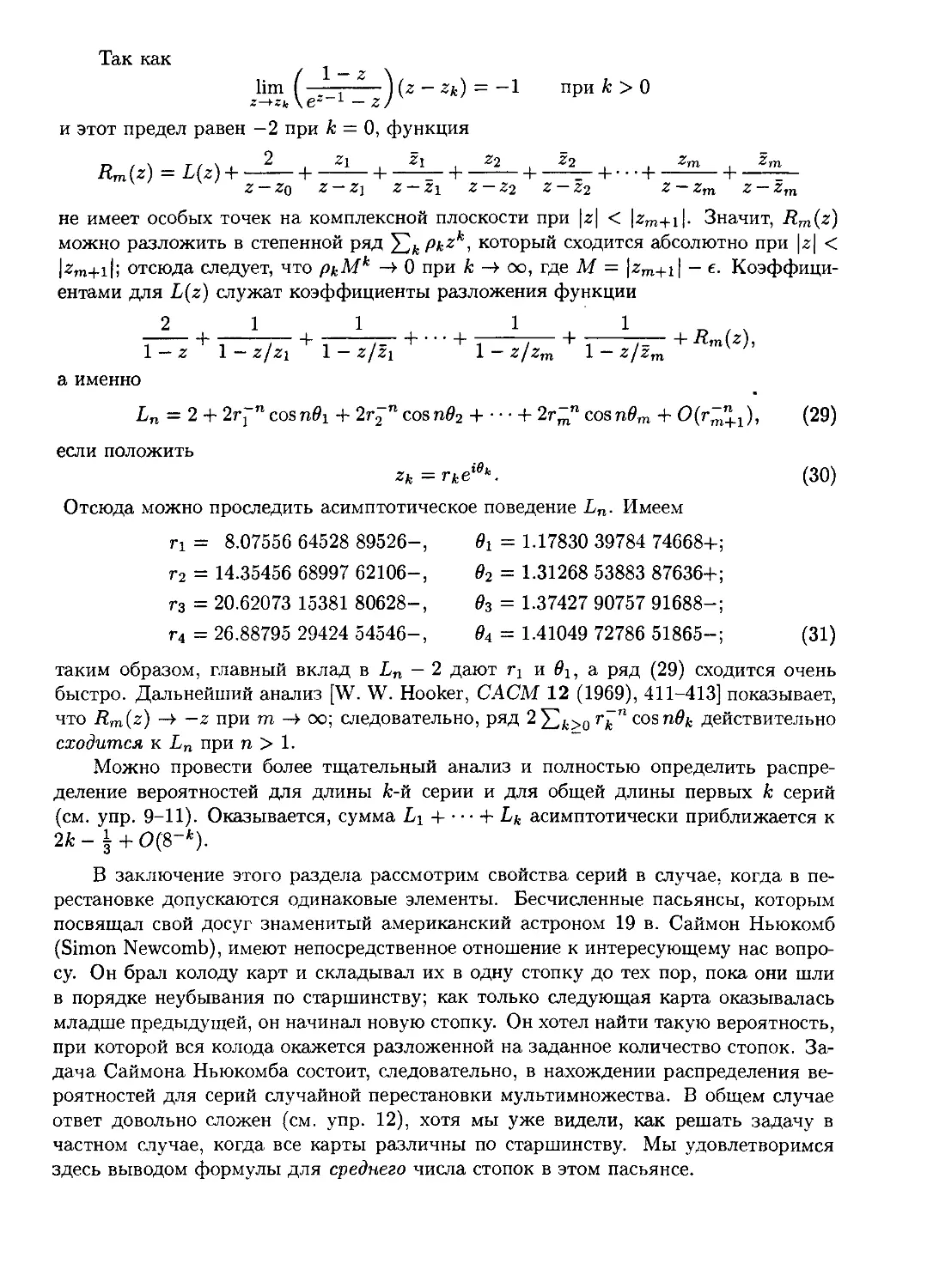

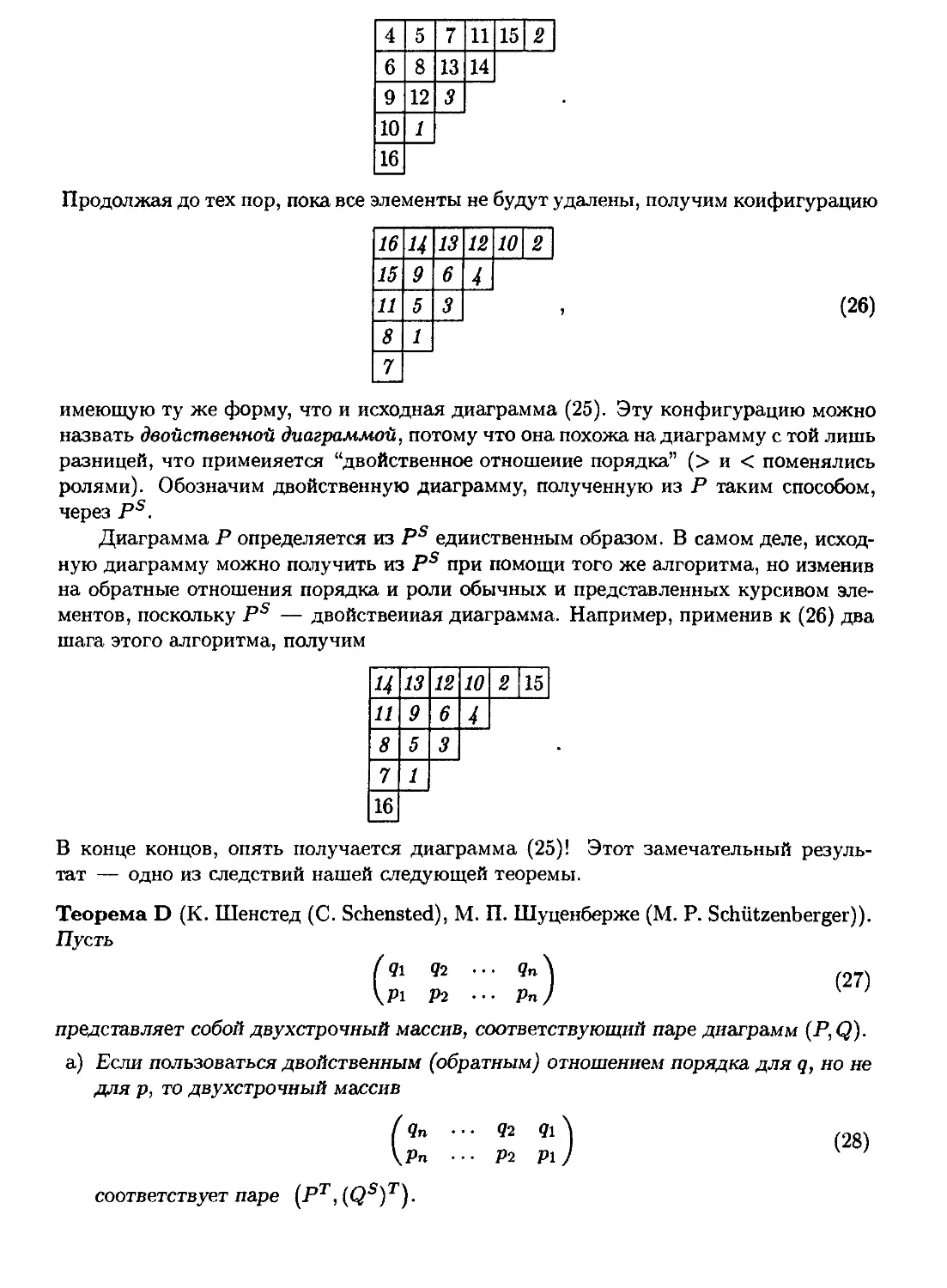

также принадлежит S.)