Автор: Паклин Н.Б. Орешков В.И.

Теги: математическая экономика экономика экономические науки бизнес аналитика

ISBN: 978-5-459-00717-6

Год: 2013

Текст

Н. Паклин, В. Орешков

БИЗНЕС-

АНАЛИТИКА:

от данных к знаниям

Учебное пособие

2-е издание,

исправленное

/X BaseGroup Labs

7- ^ТЕХНОЛОГИИ АНАЛИЗА ДАННЫХ

СЕЛИГЕР'

Москва • Санкт-Петербург Нижний Новгород Воронеж

Ростов-на-Дону • Екатеринбург Самара Новосибирск

Киев Харьков Минск

2013

ББК 65. вб

УДК 330.43

П13

Рецензенты:

Завкафедрой информационных систем и технологий Нижегородского филиала

Государственного университета — Высшей школы экономики, канд. техн, наук,

профессор Э. А. Бабкин;

Директор научно-исследовательского института Российской экономической академии

им. Г. В. Плеханова, д-р техн, наук, профессор О. А. Косорукое.

Паклин Н. Б., Орешков В. И.

П13 Бизнес-аналитика: от данных к знаниям (+CD): Учебное пособие. 2-е изд.,

испр. — СПб.: Питер, 2013. — 704 с.: ил.

ISBN 978-5-459-00717-6

Книга представляет собой руководство для профессиональных бизнес-аналитиков, занимаю-

щихся внедрением корпоративных аналитических систем. В теоретической части последовательно

освещаются современные технологии сбора и анализа структурированной информации: хранили-

ща данных, ETL, OLAP, Data Mining, Knowledge Discovery in Databases. В практической части

приводятся примеры решения бизнес-задач на аналитической платформе Deductor Academic.

В данное, второе, издание включены разделы по последовательным шаблонам, байесовскому

классификатору, обучению в условиях несбалансированности классов, расширена практическая

часть.

Книга будет полезна всем интересующимся вопросами интеллектуального анализа данных

и методами автоматического поиска закономерностей в массивах информации.

Для специалистов в области анализа данных, студентов и аспирантов.

ББК65.В6

УДК 330.43

Все права защищены. Никакая часть данной книги не может быть воспроизведена в какой бы то ни было фор-

ме без письменного разрешения владельцев авторских прав.

ISBN 978-5Щ59-00717-6

© ООО Издательство «Питер», 2013

Краткое содержание

Предисловие авторов...............................................8

Об авторах.......................................................10

От издательства..................................................11

Вступительное слово..............................................12

Введение.........................................................14

ЧАСТЬ I. ТЕОРИЯ БИЗНЕС-АН АЛ ИЗА

Глава 1. Технологии анализа данных...............................20

Глава 2. Консолидация данных.....................................61

Глава 3. Трансформация данных...................................138

Глава 4. Визуализация данных....................................173

Глава 5. Очистка и предобработка данных.........................211

Глава 6. Data Mining: задача ассоциации.........................281

Глава 7. Data Mining: кластеризация.............................308

Глава 8. Data Mining: классификация и регрессия.

Статистические методы...........................................342

Глава 9. Data Mining: классификация и регрессия.

Машинное обучение...............................................428

Глава 10. Анализ и прогнозирование временных рядов..............514

Глава 11. Ансамбли моделей......................................543

Глава 12. Сравнение моделей.....................................563

ЧАСТЬ II. БИЗНЕС-АНАЛИЗ В DEDUCTOR

Глава 13. Аналитическая платформа Deductor......................600

Глава 14. Консолидация данных и аналитическая отчетность

аптечной сети...................................................606

Глава 15. Ассоциативные правила в стимулировании

розничных продаж................................................635

Глава 16. Сегментация клиентов телекоммуникационной компании....643

Глава 17. Скоринговые модели для оценки кредитоспособности

заемщиков.......................................................657

Глава 18. Прогнозирование продаж товаров в оптовой компании.....676

Глава 19. Повышение эффективности массовой рассылки клиентам....682

Заключение......................................................689

Литература......................................................690

Алфавитный указатель............................................693

Оглавление

Предисловие авторов.....................................................8

Об авторах..............................................................10

От издательства.........................................................11

Вступительное слово.....................................................12

Введение...............................................................14

Современная бизнес-аналитика............................................14

ЧАСТЬ I. ТЕОРИЯ БИЗНЕС-АНАЛИЗА

Глава 1. Технологии анализа данных.....................................20

1.1. Введение в анализ данных..........................................20

1.2. Принципы анализа данных...........................................25

1.3. Структурированные данные..........................................30

1.4. Подготовка данных к анализу.......................................34

1.5. Технологии KDD и Data Mining......................................40

1.6. Аналитические платформы...........................................47

1.7. Введение в алгоритмы Data Mining..................................51

Глава 2. Консолидация данных...........................................61

2.1. Задача консолидации...............................................61

2.2. Введение в хранилища данных.......................................65

2.3. Основные концепции хранилищ данных................................71

2.4. Многомерные хранилища данных......................................76

2.5. Реляционные хранилища данных......................................82

2.6. Гибридные хранилища данных........................................86

Оглавление 5

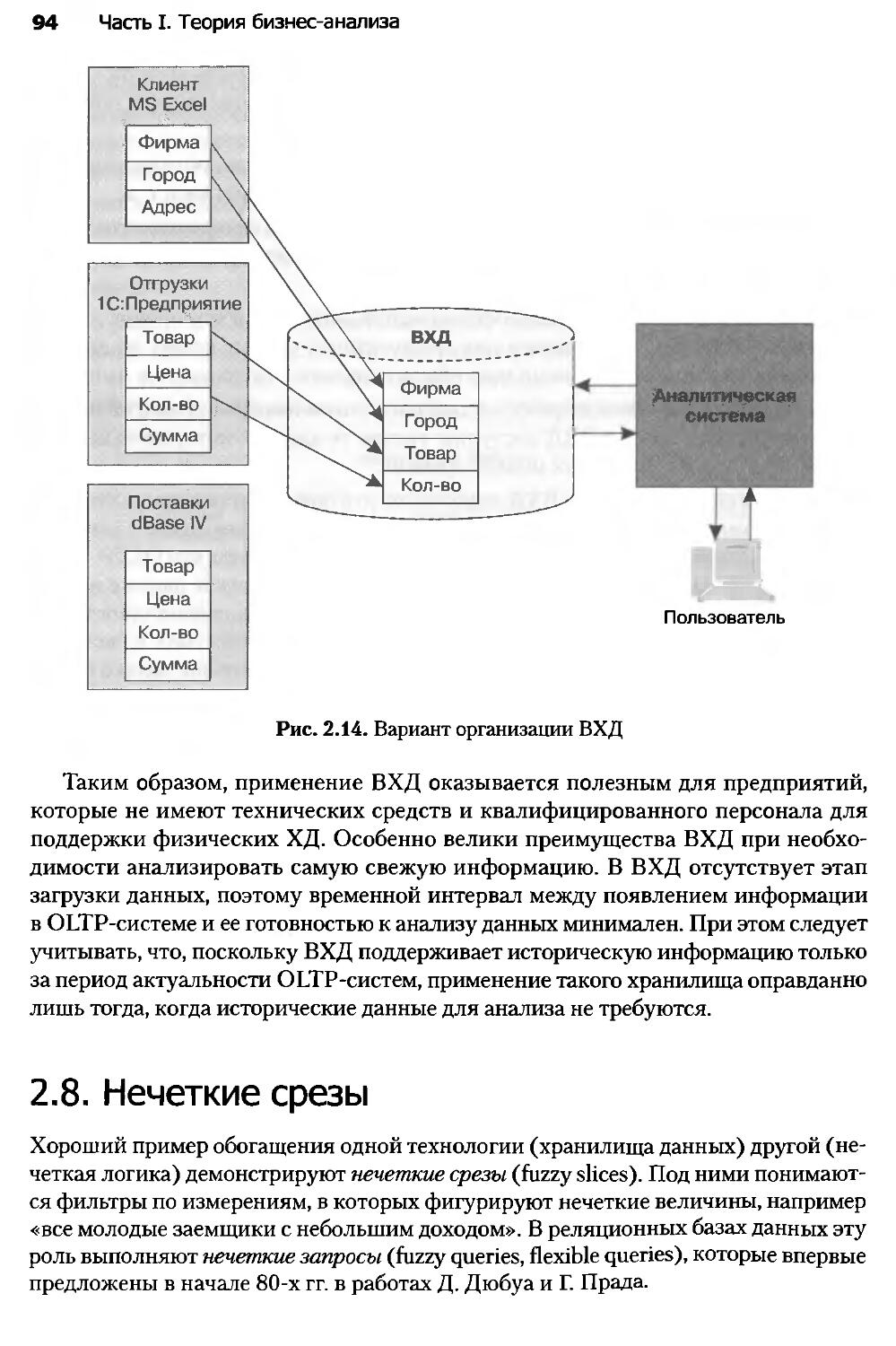

2.7. Виртуальные хранилища данных.......................................91

2.8. Нечеткие срезы.....................................................94

2.9. Введение в ETL....................................................100

2.10. Извлечение данных в ETL..........................................103

2.11. Очистка данных в ETL.............................................108

2.12. Преобразование данных в ETL......................................113

2.13. Загрузка данных в хранилище......................................119

2.14. Загрузка данных из локальных источников..........................123

2.15. Обогащение данных................................................131

Глава 3. Трансформация данных..........................................138

3.1. Введение в трансформацию данных...................................138

3.2. Трансформация упорядоченных данных................................142

3.3. Группировка данных................................................151

3.4. Слияние данных....................................................154

3.5. Квантование.......................................................160

3.6. Нормализация и кодирование данных.................................166

Глава 4. Визуализация данных...........................................173

4.1. Введение в визуализацию...........................................173

4.2. Визуализаторы общего назначения...................................177

4.3. OLAP-анализ.......................................................184

4.4. Визуализаторы для оценки качества моделей.........................192

4.5. Визуализаторы, применяемые для интерпретации результатов анализа..202

Глава 5. Очистка и предобработка данных................................211

5.1. Оценка качества данных............................................211

5.2. Технологии и методы оценки качества данных........................217

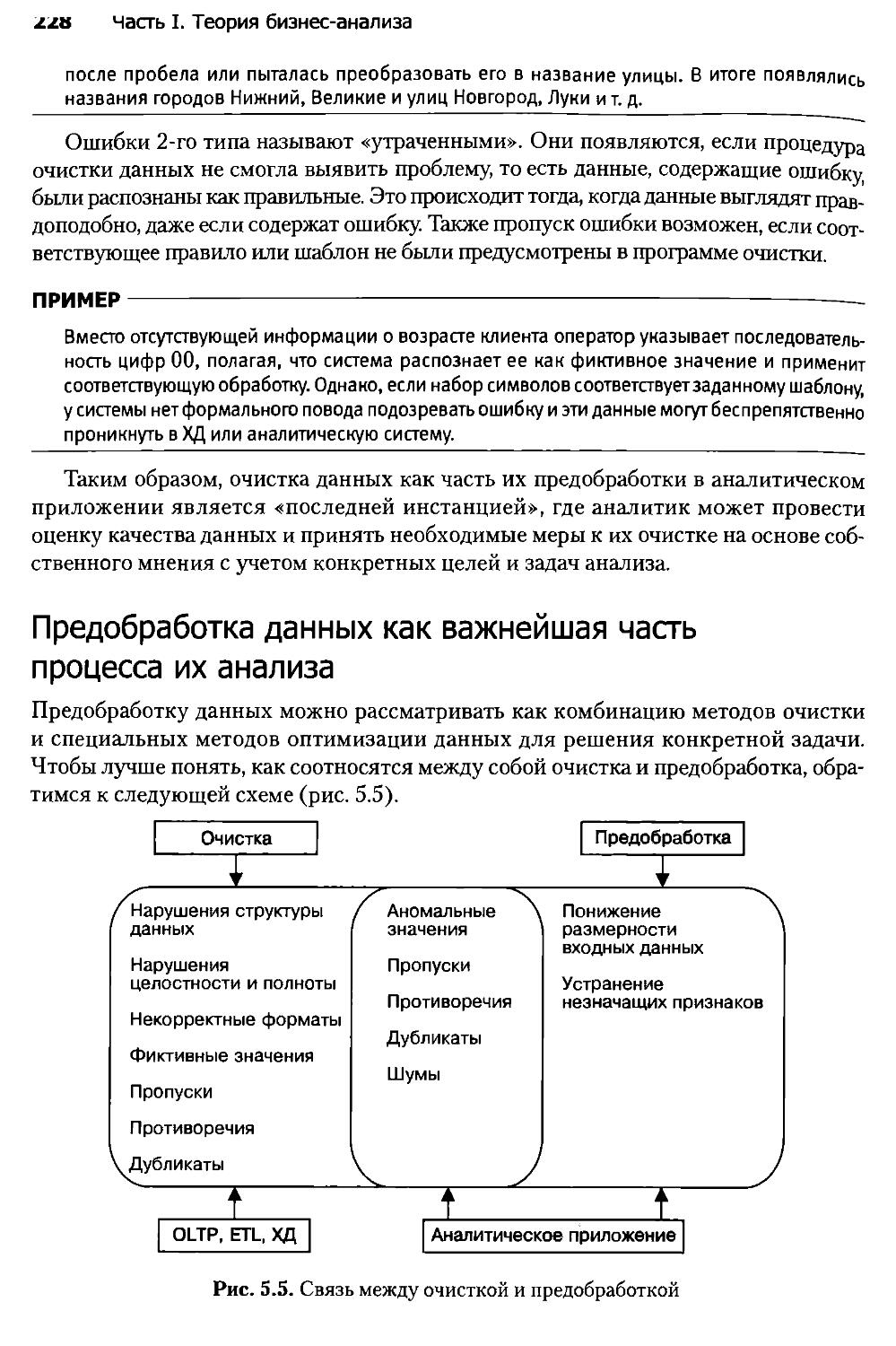

5.3. Очистка и предобработка...........................................224

5.4. Фильтрация данных.................................................232

5.5. Обработка дубликатов и противоречий...............................234

5.6. Выявление аномальных значений.....................................240

5.7. Восстановление пропущенных значений...............................247

5.8. Введение в сокращение размерности.................................253

5.9. Сокращение числа признаков........................................258

5.10. Сокращение числа значений признаков и записей....................270

5.11. Сэмплинг.........................................................273

Глава б. Data Mining: задача ассоциации................................281

6.1. Ассоциативные правила.............................................281

6.2. Алгоритм Apriori..................................................287

6.3. Иерархические ассоциативные правила...............................292

6.4. Последовательные шаблоны..........................................299

б Оглавление

Глава 7. Data Mining: кластеризация.....................................308

7.1. Введение в кластеризацию...........................................308

7.2. Алгоритм кластеризации k-means.....................................311

7.3. Сети Кохонена......................................................322

7.4. Карты Кохонена.....................................................330

7.5. Проблемы алгоритмов кластеризации..................................337

Глава 8. Data Mining: классификация и регрессия.

Статистические методы...................................................342

8.1. Введение в классификацию и регрессию...............................342

8.2. Простая линейная регрессия.........................................351

8.3. Оценка соответствия простой линейной регрессии реальным данным....356

8.4. Простая регрессионная модель.......................................363

8.5. Множественная линейная регрессия...................................370

8.6. Модель множественной линейной регрессии............................376

8.7. Регрессия с категориальными входными переменными...................380

8.8. Методы отбора переменных в регрессионные модели....................387

8.9. Ограничения применимости регрессионных моделей.....................396

8.10. Основы логистической регрессии....................................403

8.11. Интерпретация модели логистической регрессии......................411

8.12. Множественная логистическая регрессия.............................421

8.13. Простой байесовский классификатор.................................423

Глава 9. Data Mining: классификация и регрессия.

Машинное обучение.......................................................428

9.1. Введение в деревья решений.........................................428

9.2. Алгоритмы построения деревьев решений..............................437

9.3. Алгоритмы ID3 и С4.5...............................................444

9.4. Алгоритм CART......................................................459

9.5. Упрощение деревьев решений.........................................465

9.6. Введение в нейронные сети..........................................472

9.7. Искусственный нейрон...............................................478

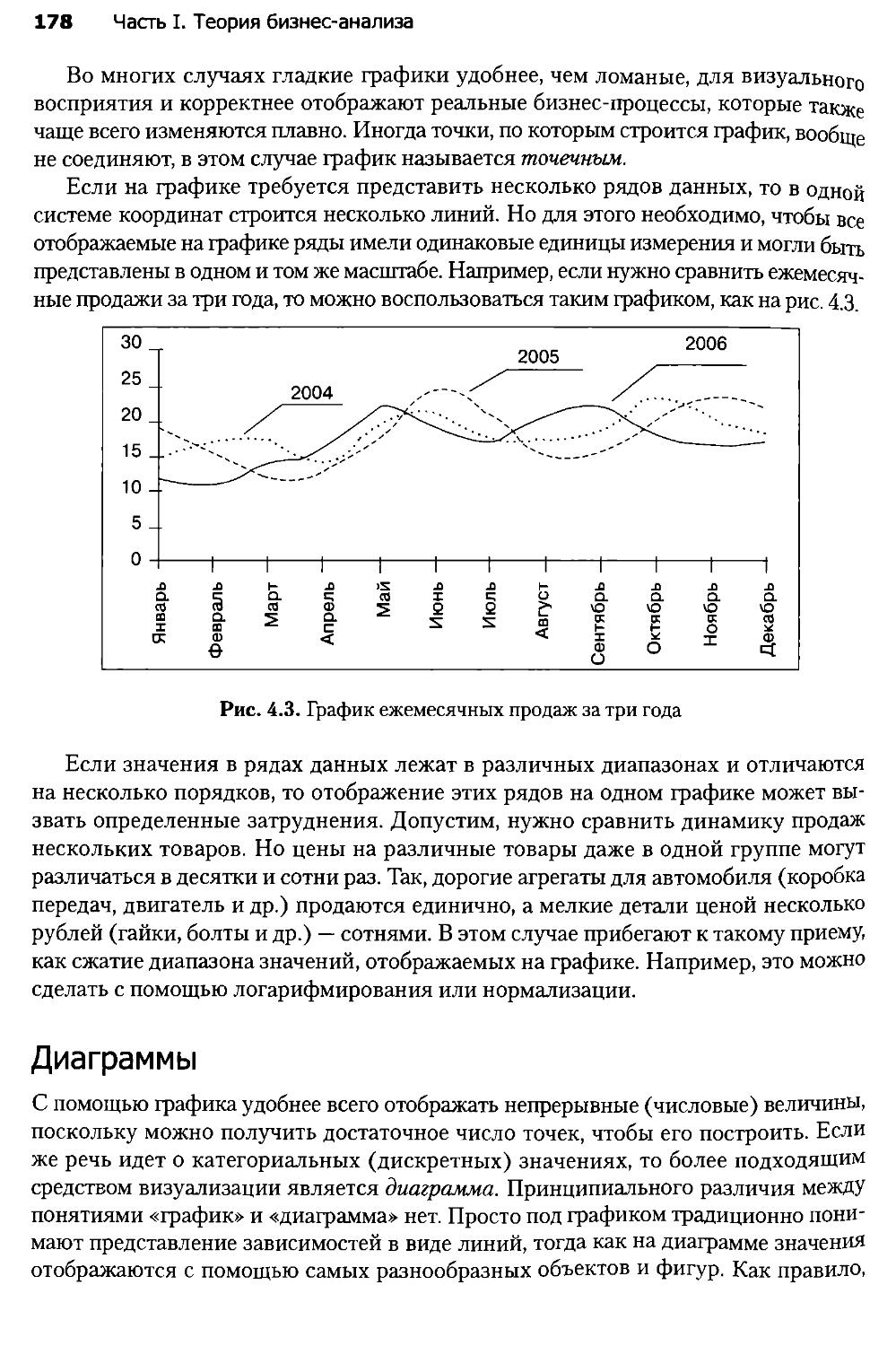

9.8. Принципы построения нейронных сетей................................484

9.9. Процесс обучения нейронной сети....................................490

9.10. Алгоритмы обучения нейронных сетей................................498

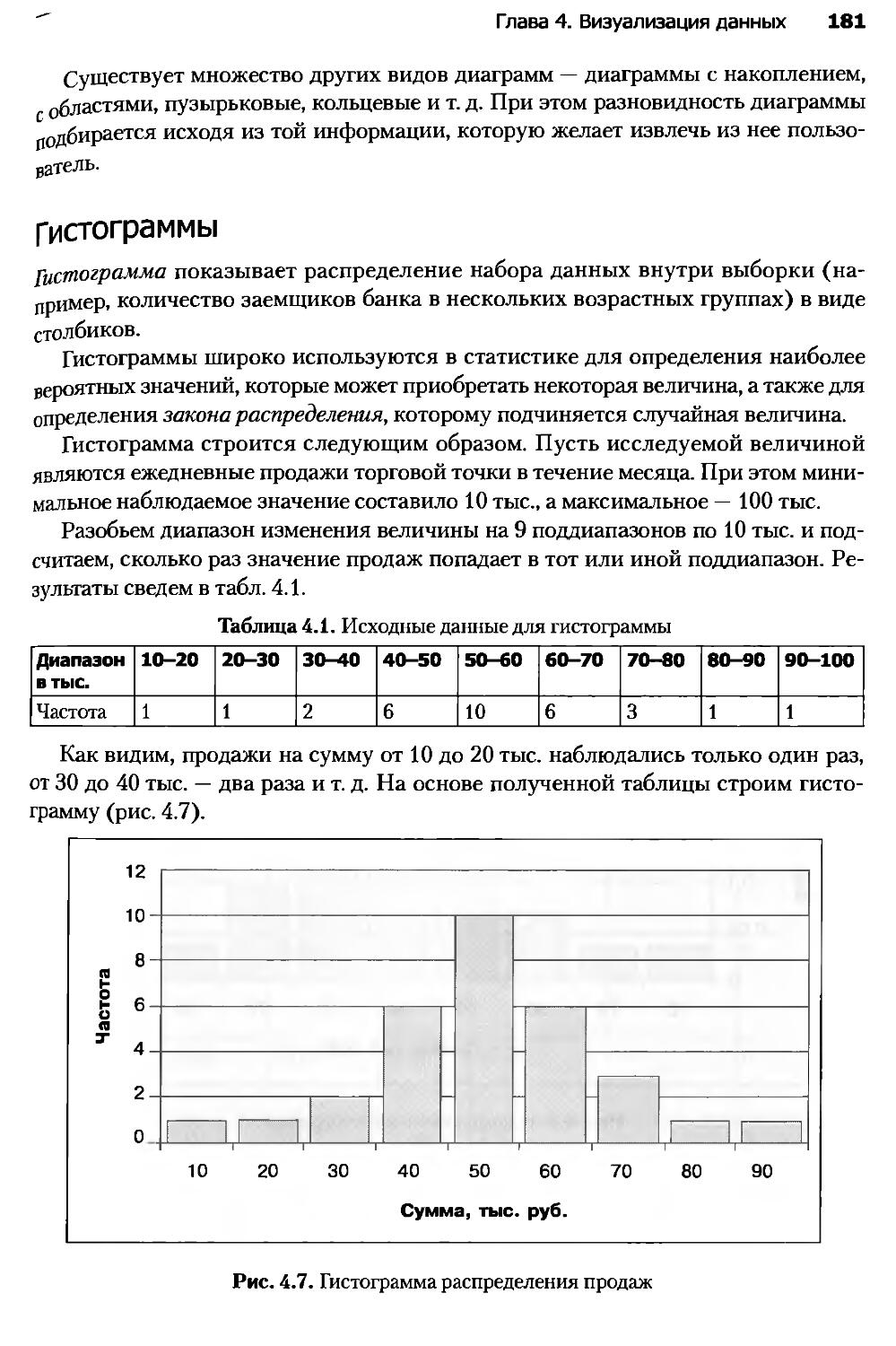

9.11. Алгоритм обратного распространения ошибки.........................507

Глава 10. Анализ и прогнозирование временных рядов......................514

10.1. Введение в прогнозирование........................................514

10.2. Временной ряд и его компоненты....................................516

10.3. Модели прогнозирования............................................532

10.4. Прогнозирование в торговле и логистике............................540

Оглавление 7

Глава 11. Ансамбли моделей........................................543

11.1. Введение в ансамбли моделей.................................543

11.2. Бэггинг.....................................................548

11.3. Бустинг.....................................................553

11.4. Альтернативные методы построения ансамблей..................557

Глава 12. Сравнение моделей.......................................563

12.1. Оценка эффективности и сравнение моделей....................563

12.2. Оценка ошибки модели........................................567

12.3. Издержки ошибочной классификации............................572

12.4. Lift- и Profit-кривые.......................................576

12.5. ROC-анализ..................................................586

12.6. Обучение в условиях несбалансированности классов............593

ЧАСТЬ II. БИЗНЕС-АНАЛИЗ В DEDUCTOR

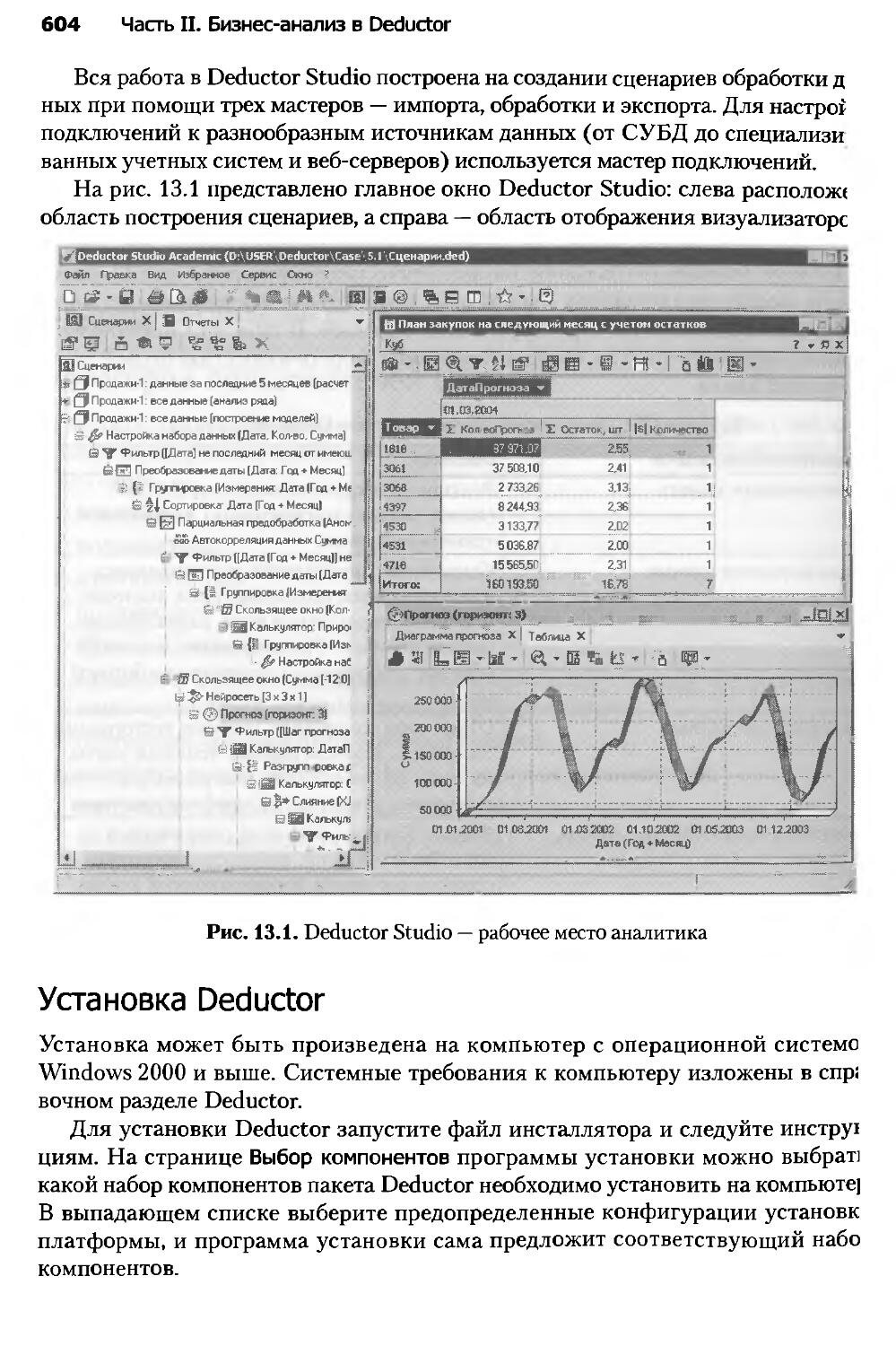

Глава 13. Аналитическая платформа Deductor........................600

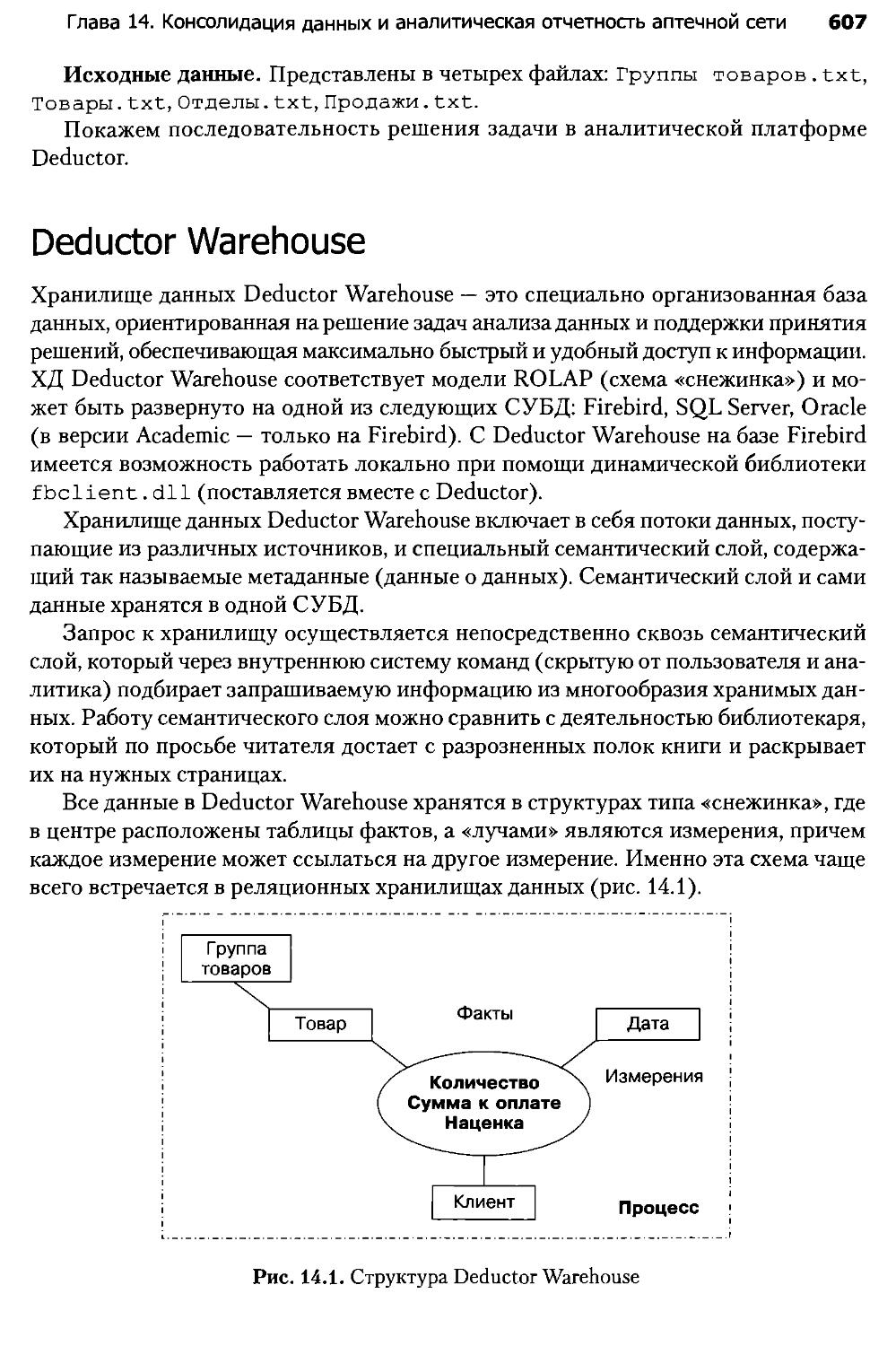

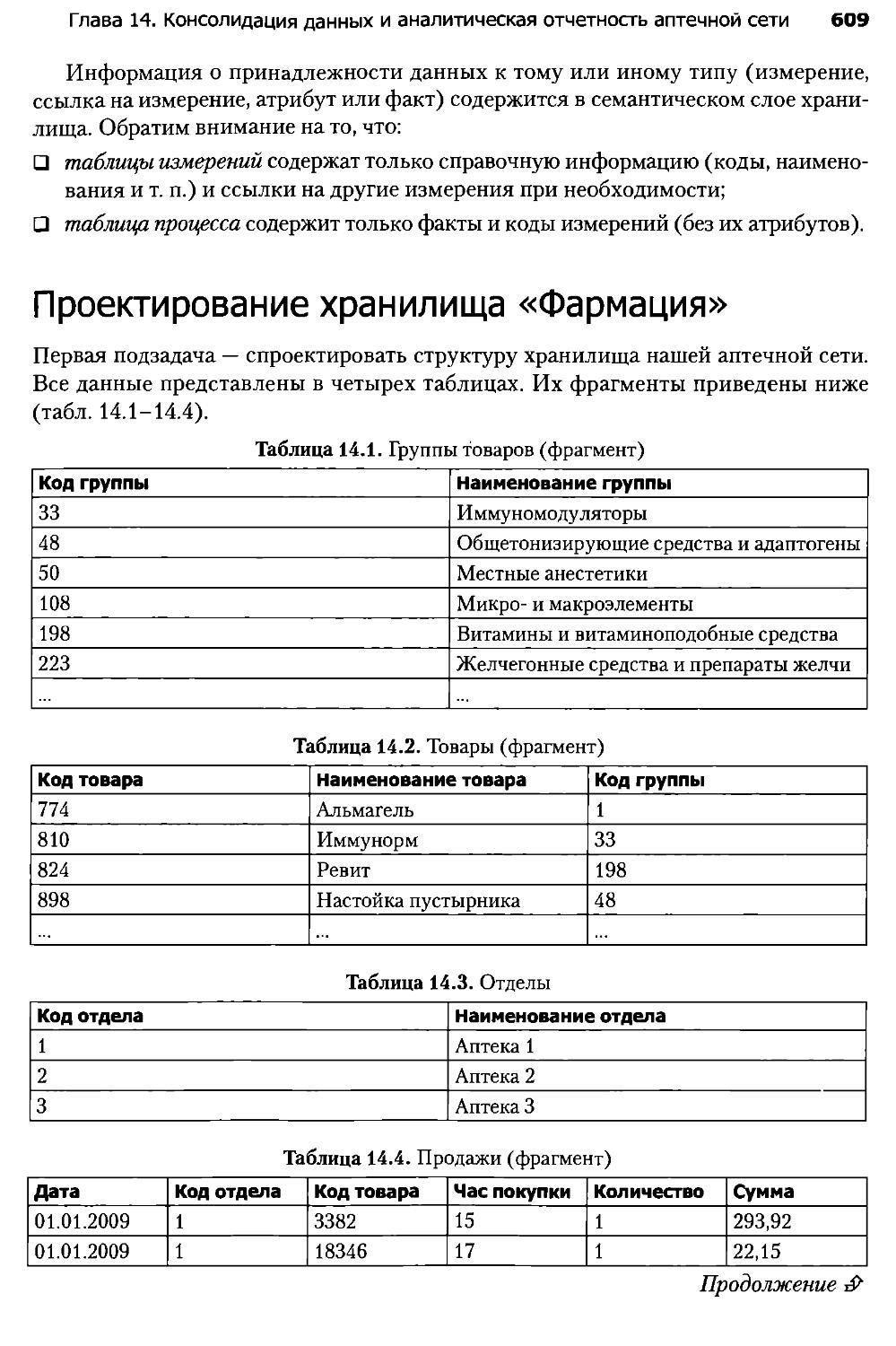

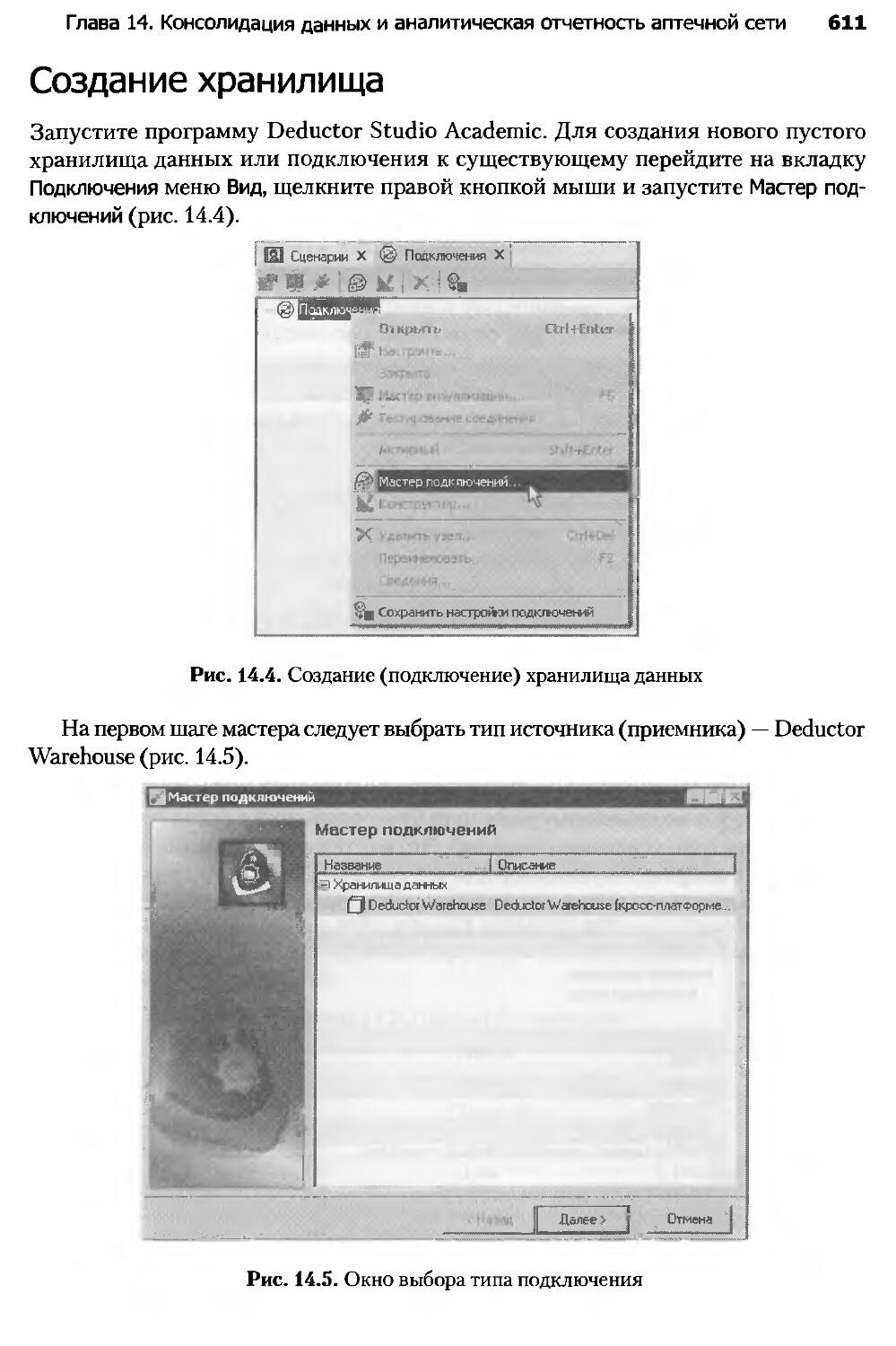

Глава 14. Консолидация данных и аналитическая отчетность

аптечной сети.....................................................606

Глава 15. Ассоциативные правила в стимулировании

розничных продаж..................................................635

Глава 16. Сегментация клиентов телекоммуникационной компании......643

Глава 17. Скоринговые модели для оценки кредитоспособности

заемщиков.........................................................657

Глава 18. Прогнозирование продаж товаров в оптовой компании.......676

Глава 19. Повышение эффективности массовой рассылки клиентам......682

Заключение........................................................689

Литература........................................................690

Алфавитный указатель..............................................693

Предисловие авторов

Книга, которую вы держите в руках, в какой-то степени уникальна. Во-первых, ей

присущи системность и глубина изложения материала, чего так не хватает россий-

ским изданиям по бизнес-аналитике (да и самих книг, к сожалению, единицы). Во-

вторых, материал рассчитан не на разработчиков информационно-аналитических

систем (проще говоря, программистов), а на тех, кто этими системами пользует-

ся, — аналитиков. В-третьих, большинство рассмотренных технологий анализа

данных можно проверить в действии на примере решения актуальных бизнес-задач

(создание хранилищ данных, OLAP, скоринг, оптимизация массовой рассылки

и др.) на аналитической платформе Deductor Academic.

Несмотря на то что у книги два автора, за этим проектом стоит много талантли-

вых людей, и в первую очередь — коллектив российской компании BaseGroup Labs,

разработчика аналитической платформы Deductor. На протяжении многих лет ком-

пания целенаправленно занимается анализом данных, и сегодня ощутимы резуль-

таты этой кропотливой работы — десятки выполненных проектов, более 90 вузов-

партнеров, образовательный портал с e-learning-курсами по бизнес-аналитике,

накопленный опыт решения разнообразных бизнес-аналитических задач.

Книга в целом ориентирована на широкий круг читателей — от 1Т-специа-

листов до экономистов и медиков — то есть на всех желающих познакомиться

с современными технологиями анализа данных. Однако в значительной мере мы

ее писали для аналитиков, которые хотят, чтобы накопленные в компании данные

превратились в знания, а не лежали мертвым грузом.

Как учебное пособие книга в первую очередь предназначена для студентов на-

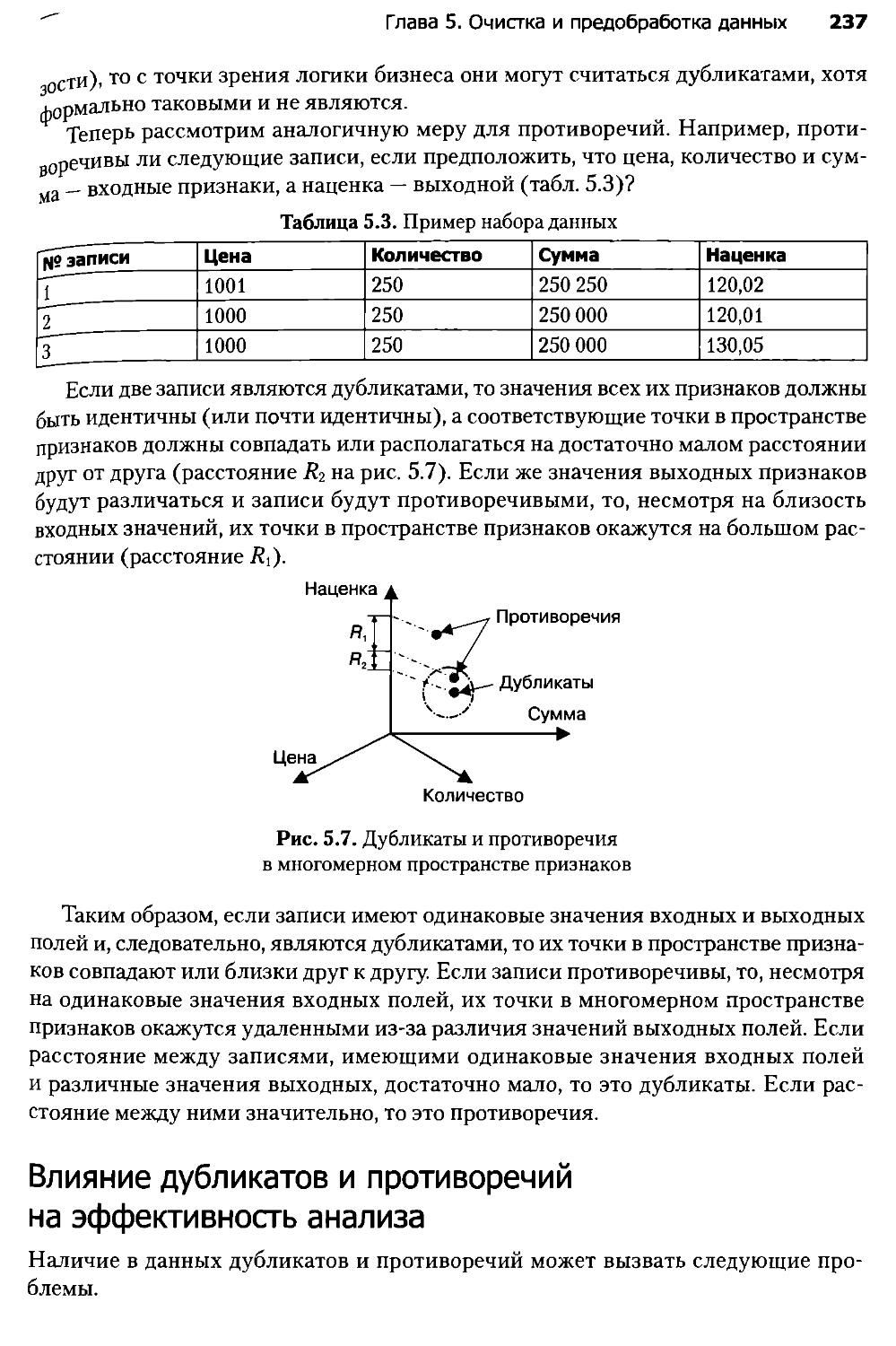

правлений и специальностей «Прикладная информатика», «Бизнес-информатика»,

а также других родственных направлений.

Области, которые затрагивает современная бизнес-аналитика, многочисленны.

Это математика, информатика, базы данных, статистика, методы визуализации

и многие другие. При написании глав, относящихся к теории бизнес-анализа, нам

часто приходилось искать баланс между полнотой и простотой изложения. Исполь-

зование Data Mining требует осторожности, поскольку некорректное применение

его методов и технологий, вызванное недостаточными знаниями и квалифика-

цией, может привести к ложным выводам и неправильно принятым на их основе

решениям. Поэтому профессиональный аналитик должен хорошо владеть этими

технологиями. Именно по этим причинам значительное внимание в книге уделено

вопросам сбора и консолидации, преобразования и очистки данных, алгоритмам,

а также методическим моментам процесса анализа — выдвижению гипотез, сбору

информации, типам и видам данных. Очень ценным мы считаем материал глав 11

и 12, так как вопросы сравнения моделей и их ансамблей в русскоязычных источ-

Предисловие авторов 9

никах освещены скудно, и мы искренне надеемся, что он будет полезен не только

начинающим, но и опытным бизнес-аналитикам.

Сюжеты некоторых из приведенных в учебном пособии примеров позаимствова-

ны из двух замечательных книг — Data Mining Methods and Models (2006) и Discovering

Knowledge in Data (2005) американского профессора Daniel T. Larose.

Интерес, проявленный к первому изданию настоящей книги (2009 г.), подвиг-

нул нас на подготовку второго. В текст были внесены изменения, направленные

на уточнение и углубление некоторых понятий и определений; исправлены обна-

руженные, в том числе с помощью читательских отзывов, опечатки, неточности

и ошибки. В книгу добавлены новые материалы по нечетким срезам, последова-

тельным шаблонам, байесовскому классификатору, кривым «точность — полнота»,

обучению в условиях несбалансированности классов. Как и в первом издании,

мы не ставили цель охватить все существующие в бизнес-аналитике алгоритмы

и методы, но то, что предлагается для изучения, рассказывается подробно и почти

всегда поясняется при помощи расчетного примера. Существенной переработке

подверглись глава 8 и материал о визуализации связей в главе 4. Кроме того,

в части II практическим примерам уделено больше внимания по сравнению с пре-

дыдущим изданием.

Общая концепция книги, введение, заключение, глава 1, разделы 2.8, 7.1, 7.5,

10.4 и все главы части II подготовлены Н. Паклиным; главы 2, 3,5,6,9-11 и разде-

лы 7.2-7.4,12.1-12.5 написаны В. Орешковым; главы 4,8 и раздел 12.6 представля-

ют собой итог совместного труда авторов. В разделе 8.8 использовались материалы,

предоставленные А. Сениным — сотрудником BaseGroup Labs.

Содержание многих глав пособия опробовано Н. Паклиным при чтении курсов

«Проектирование информационно-аналитических систем» и «Интеллектуальные

информационные системы» в Рязанском филиале Московского государственного

университета экономики, статистики и информатики.

Хочется выразить огромную благодарность: А. И. Арустамову — директору

и главному вдохновителю компании BaseGroup Labs; всем преподавателям вузов-

партнеров, активно использующих Deductor в учебном процессе; рецензентам

пособия — профессору Э. А. Бабкину и профессору О. А. Косорукову за ценные

замечания и рекомендации, которые были учтены авторами. Также выражаем

искреннюю признательность профессору МИРЭА Л. С. Болотовой за внимание

к нашей книге.

С авторами можно связаться по адресу edu@basegroup.ru. Ждем ваших пред-

ложений и замечаний.

Об авторах

Николай Паклин

Окончил Ижевский государственный технический университет по специаль-

ности «Информационные системы и технологии», в 2004 г. защитил диссертацию

на соискание ученой степени кандидата технических наук. С 2005 г. — сотрудник

компании BaseGroup Labs, в которой занимается внедрением информационно-

аналитических систем и разработкой корпоративных учебных курсов по бизнес-

аналитике. Опыт преподавательской деятельности более 5 лет. Область научных и

практических интересов связана с алгоритмами машинного обучения, Data Mining

и корпоративными информационно-аналитическими системами.

Вячеслав Орешков

Окончил Рязанскую государственную радиотехническую академию по специ-

альности «Радиоэлектронные системы и комплексы». В настоящее время — науч-

ный сотрудник кафедры радиоуправления и связи Рязанского государственного

радиотехнического университета. Сфера научных интересов — Data Mining, анализ

данных, цифровая обработка сигналов и изображений в системах телекоммуника-

ций. С 2002 г. сотрудничает с BaseGroup Labs в качестве технического писателя.

От издательства

Ваши замечания, предложения и вопросы отправляйте по адресу электронной

почты salnikova@msk.piter.com (издательство «Питер», редакция специальной ли-

тературы).

Мы будем рады узнать ваше мнение!

На сайте издательства http://www.piter.com вы найдете подробную информацию

о наших книгах.

Вступительное слово

Известно, что современное общество вступило в новый этап своего развития,

называемый информационным или постиндустриальным. Под этим обычно пони-

мается, что знания и информация стали главной движущей и производительной

общественной силой, определяющей как духовное, так и материальное состояние

личности, компании, государства в целом. От умения производить, искать, ана-

лизировать, классифицировать, обобщать, распознавать, перерабатывать, пред-

ставлять информацию и принимать решения сегодня напрямую зависят качество

жизни человека и общества, их информационная и общественная безопасность. Все

перечисленные процессы относятся к числу духовных, или идеальных. Примени-

тельно к ним справедлива прямая зависимость между уровнем духовного развития

человека, его способностями к творчеству и объемами информации, которые он

может усваивать и перерабатывать. Отсюда становится видимой стратегическая

направленность эволюции человечества в целом. Ее можно охарактеризовать как

тенденцию перехода от материального общества к духовному.

Вторая тенденция тоже проступает достаточно явно и состоит в том, что след-

ствием перехода к информационному обществу является его структурная и мате-

риальная трансформация: исчезают информационные барьеры между государст-

вами, корпорациями, языками. Глобализация — естественное следствие развития

информационного общества.

Это предъявляет новые требования к человеку, к уровню его подготовки, к его

информационной культуре. Если еще 10-15 лет назад под информационной куль-

турой личности, общества, корпорации и т. д. понималась просто компьютерная

грамотность (владение навыками работы с компьютером), то сегодня — владение

методами и технологиями работы с данными и знаниями, с базами данных и зна-

ний. Умение работать с информацией становится главным условием при приеме

на работу, при определении перспективного роста личности и компании.

Современное общество характеризуется еще одной важной деталью: оно по-

дошло к порогу, когда одновременно сконцентрировались огромные массивы

информации (в корпорациях, в государственных департаментах, в службах соци-

ального обеспечения и т. д.) в виде баз данных; значительно возросли мощности

вычислительной техники, систем и средств связи и передачи данных; Интернет

стал всеобщим единым хранилищем данных и знаний для человечества; четко

сформировалась потребность в новых возможностях взаимодействия с данными

и со средствами их обработки. Наконец, явственно сформировался социальный

заказ на достаточно полные и доступные отечественные издания, посвященные

информационно-аналитической обработке больших объемов данных, и на соответ-

ствующие программные средства. Выяснилось, например, что сведения о методах

Вступительное слово

13

и технологиях хранилищ данных и об интеллектуальном анализе данных содержат-

ся в основном в научных изданиях, в том числе в рамках тематики искусственного

интеллекта; практически отсутствуют издания, пригодные в качестве учебников

и учебных пособий для вузов.

Выход в свет такого полного и подробного издания, как «Бизнес-аналитика: от

данных к знаниям» в 2009 г., на мой взгляд, стал событием. Предлагаемое внима-

нию читателей второе издание, исправленное и дополненное новыми материалами

и примерами, является вполне логичным и необходимым.

Учебное пособие может быть использовано в первую очередь студентами и ас-

пирантами, обучающимися по специальностям, связанным с информационными

технологиями. Конечно, дисциплина под названием «Бизнес-аналитика» не входит

в вузовские учебные программы. Но многие вопросы, рассматриваемые в книге,

так или иначе включены в курсы по системам поддержки принятия решений,

искусственному интеллекту, интеллектуальным информационным технологиям.

Поэтому преподавателям будет несложно адаптировать материал пособия к чи-

таемым курсам.

Ориентация авторов на мировой уровень исследований в области бизнес-ана-

литики привела к тому, что в книге содержится довольно много англоязычных тер-

минов и аббревиатур наподобие Data Warehousing, Knowledge Discovery in Databases

и Data Mining, к которым российские читатели еще не привыкли. Да и в качестве

дополнительной литературы предлагаются в основном учебники на английском

языке. Это является определенным недостатком, хотя авторы старались сделать

пособие самодостаточным. Но достоинств у книги во много раз больше. Она

способствует формированию у читателя четкого представления о месте и роли

информационно-аналитических технологий (а также программных аналитических

платформ на их основе) в решении актуальных управленческих задач, изучению

сложившейся в этой области терминологии, освоению системных научных подхо-

дов к подготовке и анализу больших массивов данных. Важно, что присутствует

практическая часть, где на базе аналитической платформы Deductor показываются

бизнес-кейсы из различных прикладных областей: это ведет к усвоению получен-

ных теоретических знаний.

Современному бизнесу не обойтись без информационно-аналитической под-

держки, решения задач прогнозирования, управления рисками и пр. Помимо

программного обеспечения, нужны специалисты, которые будут внедрять анали-

тические проекты. Данное учебное пособие, безусловно, вносит вклад в решение

этих задач.

Л. С. Болотова,

доктор технических наук,

профессор Московского института

радиотехники, электроники и автоматики

Введение

Современная бизнес-аналитика

Еще несколько лет назад рынок корпоративных аналитических систем в России был

настолько мал, что вопросы и проблемы бизнес-аналитики обсуждались в узком

кругу профессионалов, а к запуску аналитических проектов относились с большим

недоверием.

Однако с тех пор, как компании получили возможность собирать и хранить

значительные объемы информации, ситуация коренным образом изменилась:

в стране начался экспоненциальный рост рынка систем бизнес-аналитики. Это-

му немало способствовали снижение сложности и стоимости внедрения таких

систем и примеры успешных решений в области корпоративных аналитических

систем.

Первыми возможности бизнес-аналитики оценили банки, а также страховые,

телекоммуникационные и торговые компании. Они научились извлекать полезные

знания и выгоду из огромного количества информации, собранной и хранящейся

в корпоративных базах данных. Сегодня очевидно, что без анализа данных в усло-

виях конкурентной борьбы не обойтись.

Что же скрывается за термином «бизнес-аналитика» (Business Intelligence)?

У него нет единого определения, слишком большой спектр технологий он включает

в себя. Можно признать удачным и емким определение авторитетной консалтинго-

вой компании IDC (http://idc.com/): бизнес-аналитика — это «инструменты и прило-

жения для поиска, анализа, моделирования и доставки информации, необходимой

для принятия решений». Бизнес-аналитика — мультидисциплинарная область,

находящаяся на стыке информационных технологий, баз данных, алгоритмов

интеллектуальной обработки информации, математической статистики и методов

визуализации.

Решения принимаются руководителями, и задача бизнес-аналитики — сделать

все, чтобы эти решения были оптимальными и своевременными. За готовыми

отчетами, которые, кстати, могут содержать не только цифры в различных разре-

зах, но и правила, зависимости, тенденции, прогнозы (то есть знания), скрывается

нелегкий труд бизнес-аналитика.

Эта книга адресована в первую очередь будущим бизнес-аналитикам, стремя-

щимся освоить современные технологии анализа данных или углубить имеющиеся

Введение 15

знания. Вам дается уникальная возможность не только изучить теоретические

аспекты хранилищ данных, их очистки и предобработки, Data Mining и др.,

но и приобрести навыки решения актуальных бизнес-задач на аналитической

платформе Deductor, которую уже свыше 90 вузов России, Беларуси и Украины

официально используют в учебном процессе для преподавания курсов по анализу

данных (разработчик — компания BaseGroup Labs). Книга, несомненно, будет также

интересна IT-специалистам, планирующим внедрение систем бизнес-аналитики

в компаниях и желающим поближе познакомиться с возможностями корпоратив-

ных информационно-аналитических систем.

Книга состоит из двух частей — теоретической и практической. Важно отметить,

что теория не привязана к конкретным программным продуктам, а значит, является

универсальной.

Путь от сырых данных к знаниям в бизнес-анализе довольно длинный. Поэтому

теоретическая часть книги — «Теория бизнес-анализа» — разбита на главы, каждая

из которых посвящена какой-либо одной задаче.

Первая глава «Технологии анализа данных» является вводной. В ней излага-

ются базовые сведения о принципах анализа, подготовке информации, струк-

турированных данных и технологиях Knowledge Discovery in Databases и Data

Mining.

Данные нередко хранятся в разрозненных источниках, поэтому могут иметь

различные форматы и типы. Решение задачи сбора информации, пригодной для

анализа в едином источнике, при помощи технологии многомерных и реляционных

хранилищ данных изложено в главе «Консолидация данных».

Для решения аналитических задач собранную воедино информацию часто

требуется группировать, фильтровать, кодировать и преобразовывать в опреде-

ленный вид при помощи специальных техник, о которых рассказывается в главе

«Трансформация данных».

Нерегламентированные запросы и аналитическая OLAP-отчетность — неотъ-

емлемые составляющие любого аналитического проекта по бизнес-анализу. Кроме

того, существует множество способов расширенной визуализации — от графиков

и диаграмм до специализированных визуализаторов — для оценки качества моде-

лей и интерпретации выявленных зависимостей. Все эти вопросы рассматриваются

в главе «Визуализация данных».

В условиях постоянного роста объемов информации критически важным ста-

новится качество данных. Пропуски, дубликаты, противоречия и аномалии — со

всеми этими проблемами необходимо бороться, используя специальные методы

и алгоритмы, чему посвящена глава «Очистка и предобработка данных».

Часто бизнес-аналитика ограничивается решением перечисленных выше задач.

Представленный в понятной форме отчет действительно помогает руководителю

оперативно принять решение. Но с повышением сложности задач одним только

визуальным анализом не обойтись. На помощь приходит прогнозное модели-

рование и извлечение знаний. Этим технологиям в книге уделено значительное

внимание.

16 Введение

В главах 6-9 под общим названием «Data Mining» последовательно изла-

гаются алгоритмы решения основных классов задач Data Mining: ассоциация,

кластеризация, классификация и регрессия. Рассматриваются алгоритмы ма-

шинного обучения и математической статистики, неоднократно показавшие свою

эффективность при решении практических задач в системах бизнес-аналитики:

нейронные сети, деревья решений, линейная, логистическая регрессия и др.

Алгоритмы описываются достаточно подробно: чтобы исключить опасность по-

явления недостоверных выводов и ложных тенденций, аналитик должен хорошо

понимать ограничения каждого метода и природу данных, с которыми работает

тот или иной алгоритм.

Многие процессы отражают динамику: продажи, поставки, заявки, трафик.

Поэтому в бизнес-аналитике важную роль играет прогнозирование, для чего необ-

ходимо владение методами анализа временных рядов. Эти вопросы раскрываются

в главе «Анализ и прогнозирование временных рядов».

Разнообразие алгоритмов Data Mining говорит о том, что не существует одного

универсального метода для решения всех задач. В то же время, если объединить

усилия нескольких методов, можно значительно повысить качество решения

аналитических задач. Поэтому в главе И «Ансамбли моделей» рассматриваются

современные подходы к комбинированию и объединению моделей: бустинг, бэг-

гинг и стэкинг.

Разнообразие алгоритмов порождает проблему выбора лучшей модели на основе

объективных критериев. Этому посвящена глава 12 «Сравнение моделей». В ней

рассматриваются Lift- и Profit-кривые, ROC-анализ и смежные темы. Знание мето-

дов сравнения моделей позволит при необходимости реализовать автоматический

перебор моделей, что важно при конвейерной обработке больших массивов данных

и промышленном прогнозировании.

Стоит сказать, что пособие ориентировано как на профессиональных читателей

и студентов старших курсов, так и на тех, кто только начал интересоваться анализом

данных. Можно следующим образом условно разделить читателей книги на кате-

гории:

□ специалисты в области хранилищ данных, OLAP и ETL — главы 1-5;

□ начинающие аналитики Data Mining — главы 1, 3, 4, 6 (кроме 6.3-6.5), 7, 9

(кроме 9.3, 9.4 и 9.10);

□ специалисты, занимающиеся прогнозированием временных рядов — главы 1,

3, 4,10;

□ профессиональные аналитики Data Mining — главы 1,3-12.

Глава 8 рассчитана на подготовленного читателя и требует присутствия у него

базовых знаний по теории вероятностей и математической статистике. При первом

чтении ее можно пропустить, освоив только тему «Введение в классификацию

и регрессию». Однако ценность всей главы заключается в наличии материала по

логистической регрессии, без знания которой невозможно овладеть технологиями

построения скоринговых карт оценки кредитоспособности, столь востребованными

в банковской бизнес-аналитике.

Введение 17

Те разделы по Data Mining, в которых подробно рассматриваются алгоритмы,

также рассчитаны на читателя, знающего основы вузовского курса высшей мате-

матики, и новичок может их пропустить.

Вторая часть — «Бизнес-анализ в Deductor» — содержит примеры решения за-

дач на базе аналитической платформы Deductor в различных областях: розничной

торговле, банкинге, телекоммуникациях, маркетинге. Эти разделы рекомендуются

для изучения всем читателям вне зависимости от уровня подготовки.

На прилагаемом компакт-диске содержатся дистрибутив Deductor Academic,

демонстрационные файлы с данными для примеров, приводимых в книге, а также

дополнительные материалы.

Часть

Теория

бизнес-анализа

Технологии

анализа данных

1.1. Введение в анализ данных

Методология анализа

Анализ данных — широкое понятие. Сегодня существуют десятки его определений.

В самом общем смысле анализ данных — это исследования, связанные с обсчетом

многомерной системы данных, имеющей множество параметров. В процессе анализа

данных исследователь производит совокупность действий с целью формирования

определенных представлений о характере явления, описываемого этими данными. Как

правило, для анализа данных используются различные математические методы.

Анализ данных нельзя рассматривать только как обработку информации после

ее сбора. Анализ данных — это прежде всего средство проверки гипотез и решения

задач исследователя.

Известное противоречие между ограниченными познавательными способностями

человека и бесконечностью Вселенной заставляет нас использовать модели и модели-

рование, тем самым упрощая изучение интересующих объектов, явлений и систем.

Слово «модель» (лат. inodeliuin) означает «мера», «способ», «сходство с какой-

то вещью».

Построение моделей — универсальный способ изучения окружающего мира,

позволяющий обнаруживать зависимости, прогнозировать, разбивать на группы

и решать множество других задач. Основная цель моделирования в том, что модель

должна достаточно хорошо отображать функционирование моделируемой системы.

ОПРЕДЕЛЕНИЕ--------------------------------------------------------------

Модель — объект или описание объекта, системы для замещения (при определенных усло-

виях, предположениях, гипотезах) одной системы (то есть оригинала) другой системой для

лучшего изучения оригинала или воспроизведения каких-либо его свойств.

Глава 1. Технологии анализа данных 21

ОПРЕДЕЛЕНИЕ

Моделирование — универсальный метод получения, описания и использования знаний.

Применяется в любой профессиональной деятельности.

По виду моделирования модели делят:

□ на эмпирические — полученные на основе эмпирических фактов, зависимостей;

□ теоретические — полученные на основе математических описаний, законов;

□ смешанные, полуэмпирические — полученные на основе эмпирических зависи-

мостей и математических описаний.

Нередко теоретические модели появляются из эмпирических, например, многие

законы физики первоначально были получены из эмпирических данных.

ПРИМЕР-----------------------------------------------------------------

Совокупность предприятий функционирует на рынке, обмениваясь товарами, сырьем,

услугами, информацией. Если описать экономические законы, правила взаимодействия

на рынке с помощью математических соотношений, например системы алгебраических

уравнений, где неизвестными будут величины прибыли, получаемые от взаимодействия

предприятий, а коэффициентами уравнения — значения интенсивности таких взаимодей-

ствий, то получится математическая модель экономической системы, то есть экономико-

математическая модель системы предприятий на рынке.

Таким образом, анализ данных тесно связан с моделированием.

Отметим важные свойства любой модели.

□ Упрощенность. Модель отображает только существенные стороны объекта

и, кроме того, должна быть проста для исследования или воспроизведения.

□ Конечность. Модель отображает оригинал лишь в конечном числе его отноше-

ний, и, кроме того, ресурсы моделирования конечны.

□ Приближенность. Действительность отображается моделью грубо или прибли-

женно.

□ Адекватность. Модель должна успешно описывать моделируемую систему.

□ Целостность. Модель реализует некоторую систему (то есть целое).

□ Замкнутость. Модель учитывает и отображает замкнутую систему необходимых

основных гипотез, связей и отношений.

□ Управляемость. Модель должна иметь хотя бы один параметр, изменениями

которого можно имитировать поведение моделируемой системы в различных

условиях.

Аналитический подход к моделированию

Модель в традиционном понимании представляет собой результат отображения

одной структуры (изученной) на другую (малоизученную). Так, отображая физи-

ческую систему (объект) на математическую (например, математический аппарат

22 Часть I. Теория бизнес-анализа

уравнений), получим физико-математическую модель системы, или математи-

ческую модель физической системы. Любая модель строится и исследуется при

определенных допущениях, гипотезах. Делается это обычно с помощью матема-

тических методов.

ПРИМЕР---------------------------------------------------------------------------

Рассмотрим экономическую систему. Величина ожидаемого спроса s на будущий месяц

(i + 1) рассчитывается на основе формулы s(t + 1) = [s(i) + s(t — 1) + s(t — 2)] / 3,

то есть как среднее от продаж за предыдущие три месяца. Это простейшая математиче-

ская модель прогноза продаж. При построении этой модели были приняты следующие

гипотезы.

Во-первых, годовая сезонность в продажах отсутствует.

Во-вторых, на величину продаж не влияют никакие внешние факторы: действия конкурен-

тов, макроэкономическая ситуация и т. д.

Использовать такую модель легко: имея данные о продажах за предыдущие

месяцы, по формуле мы получим прогноз на будущий месяц.

Такой подход к моделированию в литературе называют аналитическим.

Аналитический подход к моделированию базируется на том, что исследова-

тель при изучении системы отталкивается от модели (рис. 1.1). В этом случае

он по тем или иным соображениям выбирает подходящую модель. Как правило,

это теоретическая модель, закон, известная зависимость, представленная чаще

всего в функциональном виде (например, уравнение, связывающее выходной па-

раметр у с входными воздействиями xt, х2...). Варьирование входных параметров

на выходе даст результат, который моделирует поведение системы в различных

условиях.

Исследователь

Модель.

Рис. 1.1. Движение от модели к результату

ПРИМЕР-----------------------------------------------------------------------

Рассмотрим физическую систему. Тело массой т, на которое воздействует сила F, скаты-

вается по наклонной плоскости с ускорением а. Исследуя такие системы, Ньютон получил

математическое соотношение F= та. Это математическая модель физической систе-

мы. При построении этой модели были приняты следующие гипотезы.

1. Поверхность идеальна (то есть коэффициент трения равен нулю).

2. Тело находится в вакууме (то есть сопротивление воздуха равно нулю).

3. Масса тела неизменна.

4. Тело движется с одинаковым постоянным ускорением в любой точке.

При моделировании многих физических явлений мы используем закон Ньютона и дела-

ем выводы.

Глава 1. Технологии анализа данных 23

Результат моделирования может соответствовать действительности, а может

и не соответствовать. В последнем случае исследователю ничего не остается, кро-

ме как выбрать другую модель или другой метод ее исследования. Новая модель,

возможно, будет более адекватно описывать рассматриваемую систему.

При аналитическом подходе не модель «подстраивается» под действительность,

а мы пытаемся подобрать существующую аналитическую модель таким образом,

чтобы она адекватно отражала реальность.

Модель всегда исследуется каким-либо методом (численным, качественным

и т. и.). Поэтому выбор метода моделирования часто означает выбор модели.

Информационный подход к моделированию

При использовании в бизнесе традиционного аналитического подхода неизбежно

возникнут проблемы из-за несоответствия между методами анализа и реальностью,

которую они призваны отражать. Существуют трудности, связанные с формали-

зацией бизнес-процессов. Здесь факторы, определяющие явления, столь многооб-

разны и многочисленны, их взаимосвязи так «переплетены», что почти никогда не

удается создать модель, удовлетворяющую таким же условиям. Простое наложение

известных аналитических методов, законов, зависимостей на изучаемую картину

реальности не принесет успеха.

В сложности и слабой формализации бизнес-процессов главным образом «ви-

новат» человеческий фактор, поэтому бывает трудно судить о характере законо-

мерностей априори (а иногда и апостериори, после реализации какого-либо мате-

матического метода). С одинаковым успехом описывать эти закономерности могут

различные модели. Использование разных методов для решения одной и той же

задачи нередко приводит исследователя к противоположным выводам. Какой метод

выбрать? Получить ответ на подобный вопрос можно, лишь глубоко проанализи-

ровав как смысл решаемой задачи, так и свойство используемого математического

аппарата.

Поэтому в последние годы получил распространение информационный подход

к моделированию, ориентированный на использование данных. Его цель — освобож-

дение аналитика от рутинных операций и возможных сложностей в понимании

и применении современных математических методов.

При информационном подходе реальный объект рассматривается как «черный

ящик», имеющий ряд входов и выходов, между которыми моделируются некоторые

связи. Иными словами, известна только структура модели (например, нейрон-

ная сеть, линейная регрессия), а сами параметры модели «подстраиваются» под

данные, которые описывают поведение объекта. Для корректировки параметров

модели используется обратная связь — отклонение результата моделирования от

действительности, а процесс настройки модели часто носит итеративный (то есть

цикличный) характер (рис. 1.2).

Таким образом, при информационном подходе отправной точкой являются

данные, характеризующие исследуемый объект, и модель «подстраивается» под

действительность.

24 Часть I. Теория бизнес-анализа

Исследователь

Рис. 1.2. Построение модели от данных

Если при аналитическом подходе мы можем выбрать модель, даже не имея ни-

каких экспериментальных данных, характеризующих свойства системы, и начать ее

использовать, то при информационном подходе без данных невозможно построить

модель, так как ее параметры полностью определяются ими.

ПРИМЕР---------------------------------------------------------------------

В банковском риск-менеджменте широко известна модель Дюрана для расчета рей-

тинга кредитоспособности заемщика, которая получила распространение в 40-50-е гг.

XX в. На основе собственного опыта Дюран разработал балльную модель для оценки за-

емщика по совокупности его имущественных и социальных параметров (возраст, пол,

профессия ит. д.). Преодолев некоторый порог, заемщик считался кредитоспособным.

Эта модель представляет собой аналитическую зависимость у = f(X), где у — рейтинг,

X — набор признаков заемщика.

Если перед современным российским банком встанет задача рассчитать рейтинг заем-

щика, банк может воспользоваться моделью Дюрана. Однако будет ли адекватной для

современной российской действительности модель, разработанная в середине прошлого

века на Западе? Естественно, не будет, так как она не учитывает закономерности между

характеристиками российских заемщиков (возраст, образование, доход и т. д.) и дефолт-

ностью по кредитам. Если же банк возьмет собственные данные по кредитным историям

и на их основе построит модель, рассчитывающую рейтинг клиента, то, вполне вероятно,

она окажется работоспособной.

В первом случае, когда мы брали модель Дюрана, мы использовали аналитический подход.

Во втором — информационный; для построения модели нам понадобились данные — кре-

дитные истории заемщиков банка.

Модели, полученные с помощью информационного подхода, учитывают специфи-

ку моделируемого объекта, явления, в отличие от аналитического подхода. Для биз-

нес-процессов последнее качество очень важно, поэтому информационный подход лег

в основу большинства современных промышленных технологий и методов анализа

данных: Knowledge Discovery in Databases, Data Mining, машинного обучения.

Однако концепция «моделей от данных» требует тщательного подхода к ка-

честву исходных данных, поскольку ошибочные, аномальные и зашумленные

данные могут привести к моделям и выводам, не имеющим никакого отношения

к действительности. Поэтому в информационном моделировании важную роль

играют консолидация данных, их очистка и обогащение.

Глава 1. Технологии анализа данных 25

Модель, построенная на некотором множестве данных, описывающих реальный

объект или систему, может оказаться не работающей на практике, поэтому в ин-

формационном моделировании используются специальные приемы: разделение

данных на обучающее и тестовое множества, оценка обучающей и обобщающей

способностей модели, проверка предсказательной силы модели.

В дальнейшем, говоря об анализе данных, мы будем предполагать использование

именно информационного подхода. Поскольку данные могут быть представлены

в различной форме, круг рассмотрения будет ограничен областью структуриро-

ванных данных. Инструментальной поддержкой процесса построения моделей на

основе информационного подхода выступают современные технологии анализа

данных KDD и Data Mining, а средством построения прикладных решений в области

анализа — аналитические платформы.

1.2. Принципы анализа данных

Процесс анализа

В информационном подходе к анализу данных, помимо модели, присутствуют еще

три важные составляющие: эксперт, гипотеза и аналитик.

ОПРЕДЕЛЕНИЕ ------------------------------------------------------

Эксперт — специалист в предметной области, профессионал, который за годы обучения

и практической деятельности научился эффективно решать задачи, относящиеся к кон-

кретной предметной области.

Эксперт — ключевая фигура в процессе анализа. По-настоящему эффективные

аналитические решения можно получить не на основе одних лишь компьютерных

программ, а в результате сочетания лучшего из того, что могут человек и компью-

тер. Эксперт выдвигает гипотезы (предположения) и для проверки их достовер-

ности либо просматривает некие выборки различными способами, либо строит те

или иные модели.

ПРИМЕР------------------------------------------------------------

Гипотезой в анализе данных часто выступает предположение о влиянии какого-либо

фактора или группы факторов на результат. К примеру, при построении прогноза про-

даж допускается предположение, что на величину будущих продаж существенно влияют

продажи за предыдущие периоды и остатки на складе. При оценке кредитоспособности

потенциального заемщика выдвигается гипотеза, что на кредитоспособность влияют

социально-экономические характеристики клиента: возраст, образование, семейное

положение и т. п.

В крупных проектах по созданию прикладных аналитических решений участву-

ют, как правило, несколько экспертов, а также аналитик.

26 Часть I. Теория бизнес-анализа

ОПРЕДЕЛЕНИЕ

Аналитик — специалист в области анализа и моделирования. Аналитик на достаточном

уровне владеет какими-либо инструментальными и программными средствами анализа

данных, например методами Data Mining. Кроме того, в обязанности аналитика входят

функции систематизации данных, опроса мнений экспертов, координации действий всех

участников проекта по анализу данных.

Аналитик играет роль «мостика» между экспертами, то есть является связу-

ющим звеном между специалистами разных уровней и областей. Он собирает

у экспертов различные гипотезы, выдвигает требования к данным, проверяет

гипотезы и вместе с экспертами анализирует полученные результаты. Аналитик

должен обладать системными знаниями, так как помимо задач анализа на его пле-

чи часто ложатся технические вопросы, связанные с базами данных, интеграцией

с источниками данных и производительностью.

Поэтому в дальнейшем главным лицом в анализе данных мы будем считать анали-

тика, предполагая, что он тесно сотрудничает с экспертами предметных областей.

ПРИМЕР-------------------------------------------------------------------

В организации создается законченное аналитическое решение в области отчетности и про-

гнозирования продаж. Оно включает в себя консолидацию данных, настройку отчетов,

построение моделей прогнозирования и др. В реализации проекта участвуют специалисты

из нескольких подразделений предприятия: высшее руководство, экономисты, логистики,

программисты, администраторы баз данных. Аналитик обеспечивает связь между всеми

участниками проекта и координирует проект в целом.

Несмотря на то что существует множество аналитических задач, можно выде-

лить две основные группы методов их решения (рис. 1.3):

□ извлечение и визуализация данных;

□ построение и использование моделей.

Рис. 1.3. Общая схема анализа

Глава 1. Технологии анализа данных 27

Извлечение и визуализация данных

Чтобы получить новые знания об исследуемом объекте или явлении, не обязатель-

но строить сложные модели. Часто достаточно «посмотреть» на данные в нужном

виде, чтобы сделать определенные выводы или выдвинуть предположение о ха-

рактере зависимостей в системе, получить ответ на интересующий вопрос. Это

помогает сделать визуализация.

В случае визуализации аналитик некоторым образом формулирует запрос к ин-

формационной системе, извлекает нужную информацию из различных источников

и просматривает полученные результаты. На их основе он делает выводы, которые

и являются результатом анализа. Существует множество способов визуализации

данных:

□ многомерные кубы (кросс-таблицы и кросс-диаграммы);

□ таблицы;

□ диаграммы, гистограммы;

□ карты, проекции, срезы и т. п.

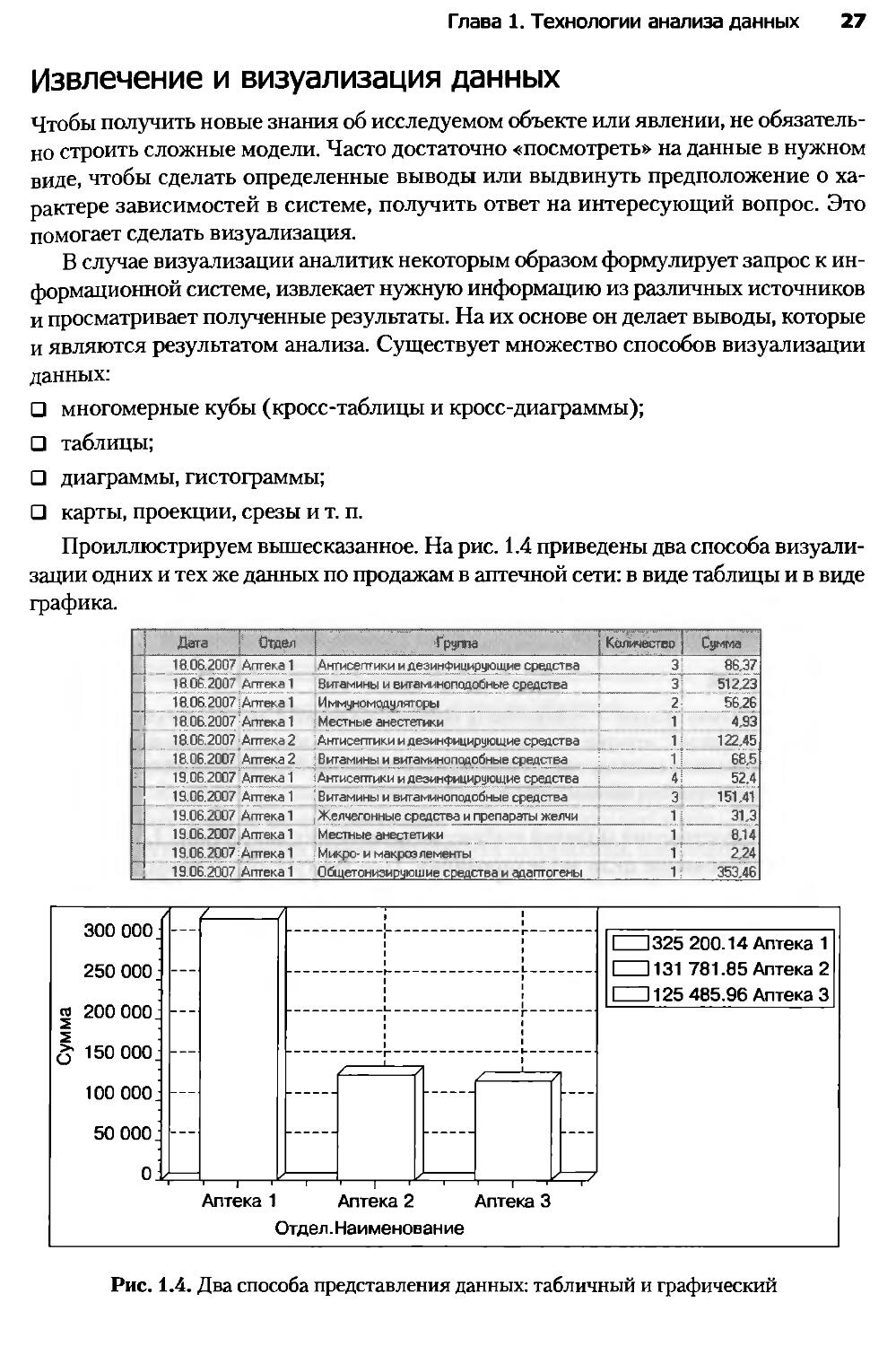

Проиллюстрируем вышесказанное. На рис. 1.4 приведены два способа визуали-

зации одних и тех же данных по продажам в аптечной сети: в виде таблицы и в виде

трафика.

Дата Is Отдел | Груте j Кш ясгео; Слима

_ „ 18.06.2007^ Аптека 1 Антисептики и дезинфицирующие средства ___ 3?_ 86,37

_j 18.06.2007 Аптека 1 Витамины и витаминоподоОные средства ‘ _____ 3; 512,23

18.06.2007 ^Аптека 1 Иммуномодуляторы= 2j_________________________ 56,26

18.06.2007 Аптека 1 ; Местные анестетики 1 4,93

18.06.2007 Аптека 2 Антисептики и дезинфицирующие средства 1 = 122,45

18.06.2007 Аптека 2 :Витамины и витаминоподобные средства _[__ 1J _ 68,5

L „ 19.06.2007 Аптека 1 ; Антисептики и дезинфицирующие средства 4] 52.4

1 19.06.2007 Аптека 1 -Витамины и витаминоподобные средства ,. 3 151,41

_ 19.06.2007 Аптека! Желчегонные средства и препараты желчи =_ 1|_ 31,3

19.06.2007 Аптека 1 Местные анестетики J 1 8,14

19.06.2007:Аптека 1 Микро-и макроэлементы 1 2,24

, 19.06.2007 Аптека 1 0бщетонизируюшие средства и адапгогены .1; 353,46

Рис. 1.4. Два способа представления данных: табличный и графический

28 Часть I. Теория бизнес-анализа

В первом случае, глядя на таблицу, нам трудно сделать какие-либо выводы

относительно динамики продаж.

Во втором варианте, представив те же данные в виде сумм продаж в разрезе

аптек и построив столбчатую диаграмму, мы видим, что самые большие продажи

приходятся на «Аптеку 1».

Несомненными достоинствами визуализации являются относительная про-

стота создания и введения в эксплуатацию подобных систем и возможность их

применения практически в любой сфере деятельности. Кроме того, в этом случае

по максимуму используются знания эксперта в предметной области и его способ-

ность принимать во внимание многие трудно формализуемые факторы, влияющие

на бизнес.

Недостатками визуализации являются неспособность людей обнаружить до-

статочно сложные и нетривиальные зависимости, а также невозможность отделить

знания от эксперта и тиражировать знания.

Этапы моделирования

Построение моделей — универсальный способ изучения окружающего мира, позво-

ляющий обнаруживать зависимости, прогнозировать, разбивать на группы и решать

множество других важных задач. Но самое главное: полученные таким образом

знания можно тиражировать.

ОПРЕДЕЛЕНИЕ ---------------------------------------------------------

Тиражирование знаний — совокупность методологических и инструментальных средств

создания моделей, которые обеспечивают конечным пользователям возможность исполь-

зовать результаты моделирования для принятия решений без необходимости понимания

методик, при помощи которых эти результаты получены.

Процесс построения моделей состоит из нескольких шагов (рис. 1.5).

Формулирование цели моделирования. При построении модели следует от-

талкиваться от задачи, которую можно рассматривать как получение ответа на

интересующий заказчика вопрос.

Например, в розничной торговле к таким вопросам относятся следующие.

□ Какова структура продаж за определенный период?

□ Какие клиенты приносят наибольшую прибыль?

□ Какие товары продаются или заказываются вместе?

□ Как оптимизировать товарные остатки на складах?

В этом случае можно говорить о создании модели прогнозирования продаж,

модели выявления ассоциаций и т. д. Данный этап также называют анализом про-

блемной ситуации.

Подготовка и сбор данных. Информационный подход к моделированию ос-

нован на использовании данных, подготовить и систематизировать которые — от-

дельная задача. Принципам подготовки данных, а также их очистке и обогащению

посвящены отдельные главы.

Глава 1. Технологии анализа данных 29

Рис. 1.5. Процесс построения модели

Поиск модели. После сбора и систематизации данных переходят к поиску моде-

ли, которая объясняла бы имеющиеся данные, позволила бы добиться эмпирически

обоснованных ответов на интересующие вопросы. В промышленном анализе дан-

ных предпочтение отдается самообучающимся алгоритмам, машинному обучению,

методам Data Mining.

Если построенная модель показывает приемлемые результаты на практике (на-

пример, в тестовой эксплуатации), ее запускают в промышленную эксплуатацию.

Так, при тестовой эксплуатации скоринговой модели, рассчитывающей кредитный

рейтинг клиента и принимающей решение о выдаче кредита, каждое решение

может подтверждаться человеком — кредитным экспертом. При запуске скоринга

в промышленную эксплуатацию человеческий фактор удаляется — теперь решение

принимает только компьютер.

Если качество модели неудовлетворительное, то процесс построения модели

повторяется, как это показано на рис. 1.5.

Моделирование позволяет получать новые знания, которые невозможно извлечь

каким-либо другим способом. Кроме того, полученные результаты представляют

собой формализованное описание некоего процесса, вследствие чего поддаются

автоматической обработке. Однако результаты, полученные при использовании

моделей, очень чувствительны к качеству данных, к знаниям аналитика и экспертов

30

Часть I. Теория бизнес-анализа

и к формализации самого изучаемого процесса. К тому же почти всегда имеются

случаи, не укладывающиеся ни в какие модели.

На практике подходы комбинируются. Например, визуализация данных на-

водит аналитика на некоторые идеи, которые он пробует проверить при помощи

различных моделей, а к полученным результатам применяются методы визуали-

зации.

Полнофункциональная система анализа не должна замыкаться на применении

только одного подхода или одной методики. Механизмы визуализации и построе-

ния моделей должны дополнять друг друга. Максимальную отдачу можно полу-

чить, комбинируя методы и подходы к анализу данных.

1.3. Структурированные данные

Данные, описывающие реальные объекты, процессы и явления, могут быть пред-

ставлены в различных формах и иметь разные тип и вид.

Формы представления данных

ОПРЕДЕЛЕНИЕ -----------------------------------------------------

Данные — сведения, которые характеризуют систему, явление, процесс или объект,

представленные в определенной форме и предназначенные для дальнейшего использо-

вания.

По степени структурированности выделяют следующие формы представления

данных:

□ неструктурированные;

□ структурированные;

□ слабоструктурированные.

К неструктурированным относятся данные, произвольные по форме, включаю-

щие тексты и графику, мультимедиа (видео, речь, аудио). Эта форма представления

данных широко используется, например, в Интернете, а сами данные представля-

ются пользователю в виде отклика поисковыми системами.

Структурированные данные отражают отдельные факты предметной области.

Структурированными называются данные, определенным образом упорядоченные

и организованные с целью обеспечения возможности применения к ним некоторых

действий (например, визуального или машинного анализа). Это основная форма

представления сведений в базах данных.

Организация того или иного вида хранения данных (структурированных или

неструктурированных) связана с обеспечением доступа к ним. Под доступом по-

нимается возможность выделения элемента данных (или множества элементов)

среди других элементов по каким-либо признакам с целью выполнения некоторых

действий над элементом.

Глава 1. Технологии анализа данных 31

Одной из самых распространенных моделей хранения структурированных дан-

ных является таблица. В ней все данные упорядочиваются в двумерную структуру,

состоящую из столбцов и строк (рис. 1.6).

Столбцы (поля, колонки, переменные, атрибуты, признаки)

Строки

(записи,

прецеденты,

примеры)

Рис. 1.6. Структурированный набор данных

В ячейках такой таблицы содержатся элементы данных: символы, числа, логи-

ческие значения.

Неструктурированные данные непригодны для обработки напрямую метода-

ми анализа данных, поэтому такие данные подвергаются специальным приемам

структуризации, причем сам характер данных в процессе структуризации может

существенно измениться.

Например, в анализе текстов (Text Mining) при структурировании из исходного

текста может быть сформирована таблица с частотами встречаемости слов, и уже

такой набор данных будет обрабатываться методами, пригодными для структури-

рованных данных.

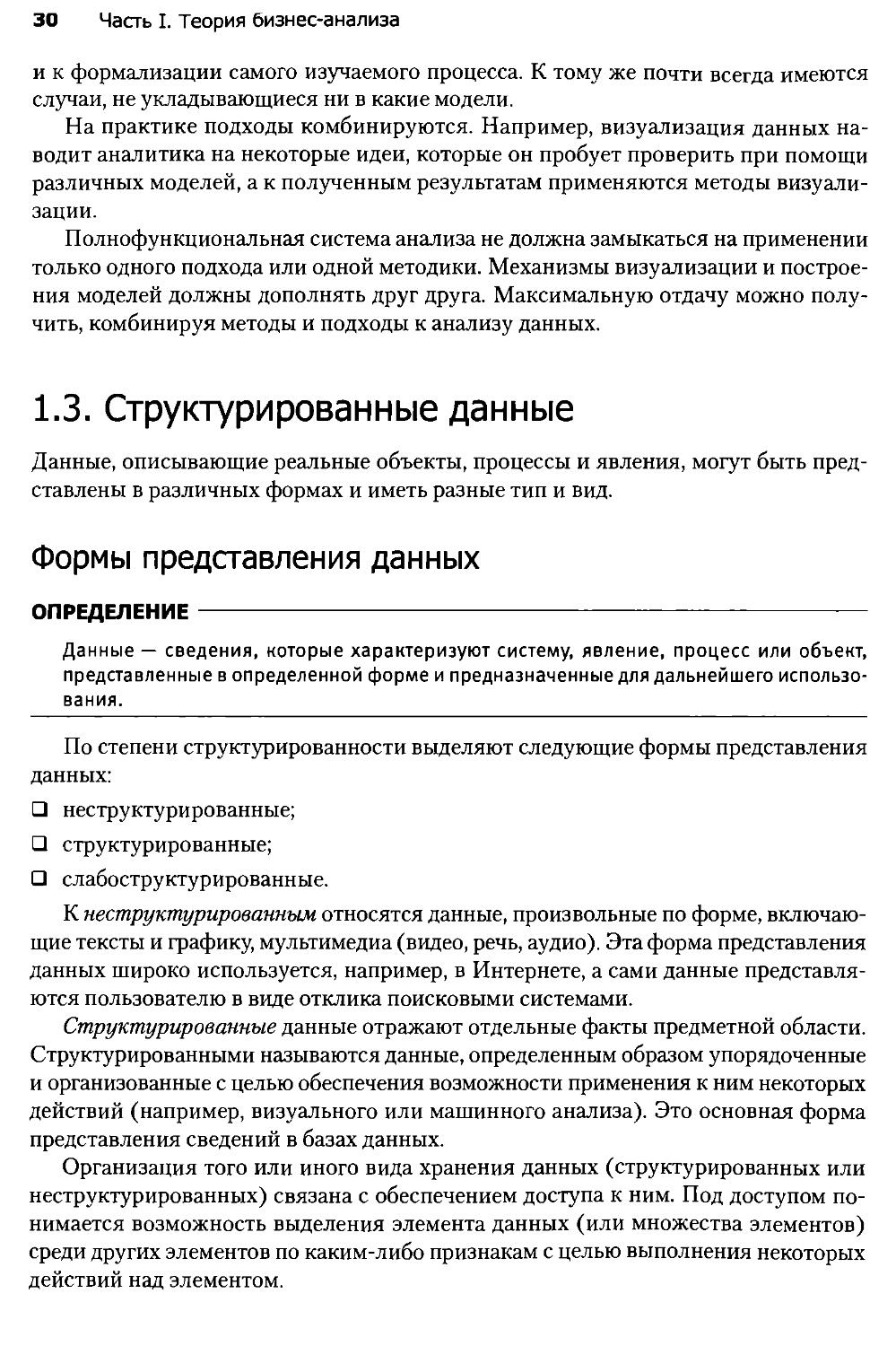

Слабоструктурированные данные — это данные, для которых определены не-

которые правила и форматы, но в самом общем виде. Например, строка с адресом,

строка в прайс-листе, ФИО и т. п. В отличие от неструктурированных, такие дан-

ные с меньшими усилиями преобразуются к структурированной форме, однако без

процедуры преобразования они тоже непригодны для анализа На рис. 1.7 приведен

пример стандартизации строки с адресом.

32

Часть I. Теория бизнес-анализа

390045 г. Рязань, ул. Ленина, д. 45 корп. 1

Поле Значение

Индекс 390045

Город Рязань

Улица Ленина

Дом 45

Корпус 1

Рис. 1.7. Стандартизация слабоструктурированных данных

Подавляющее большинство методов анализа данных работает только с хоро-

шо структурированными данными, представленными в табличном виде, поэтому

дальнейшее изложение во всей книге ведется применительно к структурированным

данным.

Типы данных

Все структурированные данные делятся на пять типов:

□ целый (количество товара, код товара и т. п.);

□ вещественный (цена, скидка и т. п.);

□ строковый (фамилия, наименование, адрес, пол, образование и т. п.);

□ логический;

□ дата/время.

Среди строковых данных можно выделить два подтипа:

□ упорядоченные (ординальные);

□ категориальные.

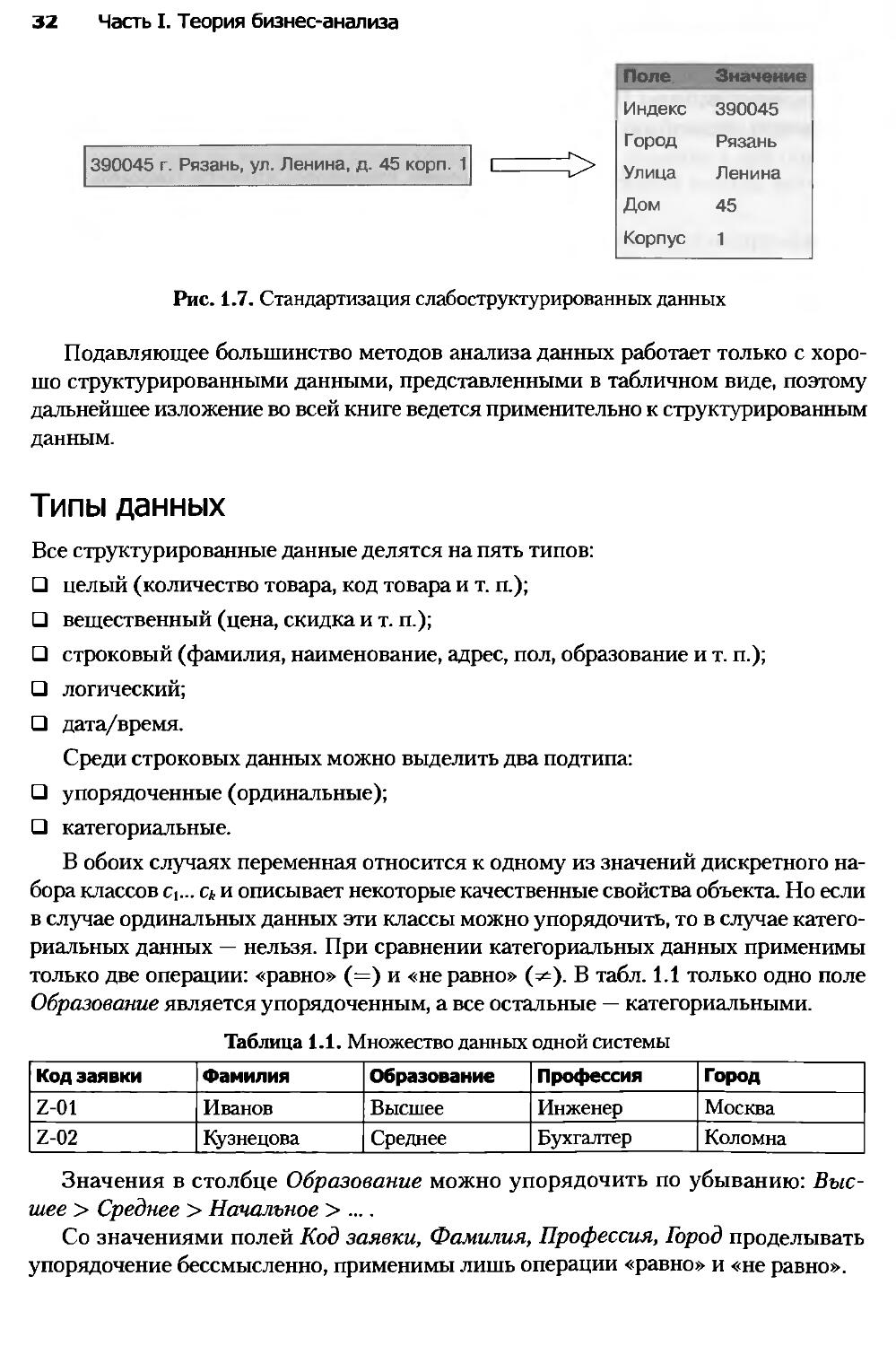

В обоих случаях переменная относится к одному из значений дискретного на-

бора классов Ct... С/, и описывает некоторые качественные свойства объекта. Но если

в случае ординальных данных эти классы можно упорядочить, то в случае катего-

риальных данных — нельзя. При сравнении категориальных данных применимы

только две операции: «равно» (=) и «неравно» (^). В табл. 1.1 только одно поле

Образование является упорядоченным, а все остальные — категориальными.

Таблица 1.1. Множество данных одной системы

Код заявки Фамилия Образование Профессия Город

Z-01 Иванов Высшее Инженер Москва

Z-02 Кузнецова Среднее Бухгалтер Коломна

Значения в столбце Образование можно упорядочить по убыванию: Выс-

шее > Среднее > Начальное > ....

Со значениями полей Код заявки, Фамилия, Профессия, Город проделывать

упорядочение бессмысленно, применимы лишь операции «равно» и «не равно».

Глава 1. Технологии анализа данных 33

Виды данных

По виду данные делятся на непрерывные и дискретные.

ОПРЕДЕЛЕНИЕ---------------------------------------------------------

Непрерывные данные — данные, значения которых могут принимать какое угодно значение

в некотором интервале. Над непрерывными данными можно производить арифметические

операции сложения, вычитания, умножения, деления, и они имеют смысл.

Примерами непрерывных данных являются возраст, любые стоимостные

показатели, количественные оценки (количество товара, объем продаж, вес от-

грузки).

ОПРЕДЕЛЕНИЕ---------------------------------------------------------

Дискретные данные — значения признака, общее число которых конечно либо бесконечно,

но может быть подсчитано при помощи натуральных чисел от одного до бесконечности.

С дискретными данными не могут быть произведены никакие арифметические действия,

либо они не имеют смысла.

Дискретными данными являются все данные строкового и логического типа.

Дискретными могут быть и числовые данные. Например, поле Код товара, прини-

мающее значения целого типа, дискретно, так как операции сложения, вычитания,

умножения над Кодом товара не имеют смысла. Соответствие возможных видов

данных типам данных приведено в табл. 1.2.

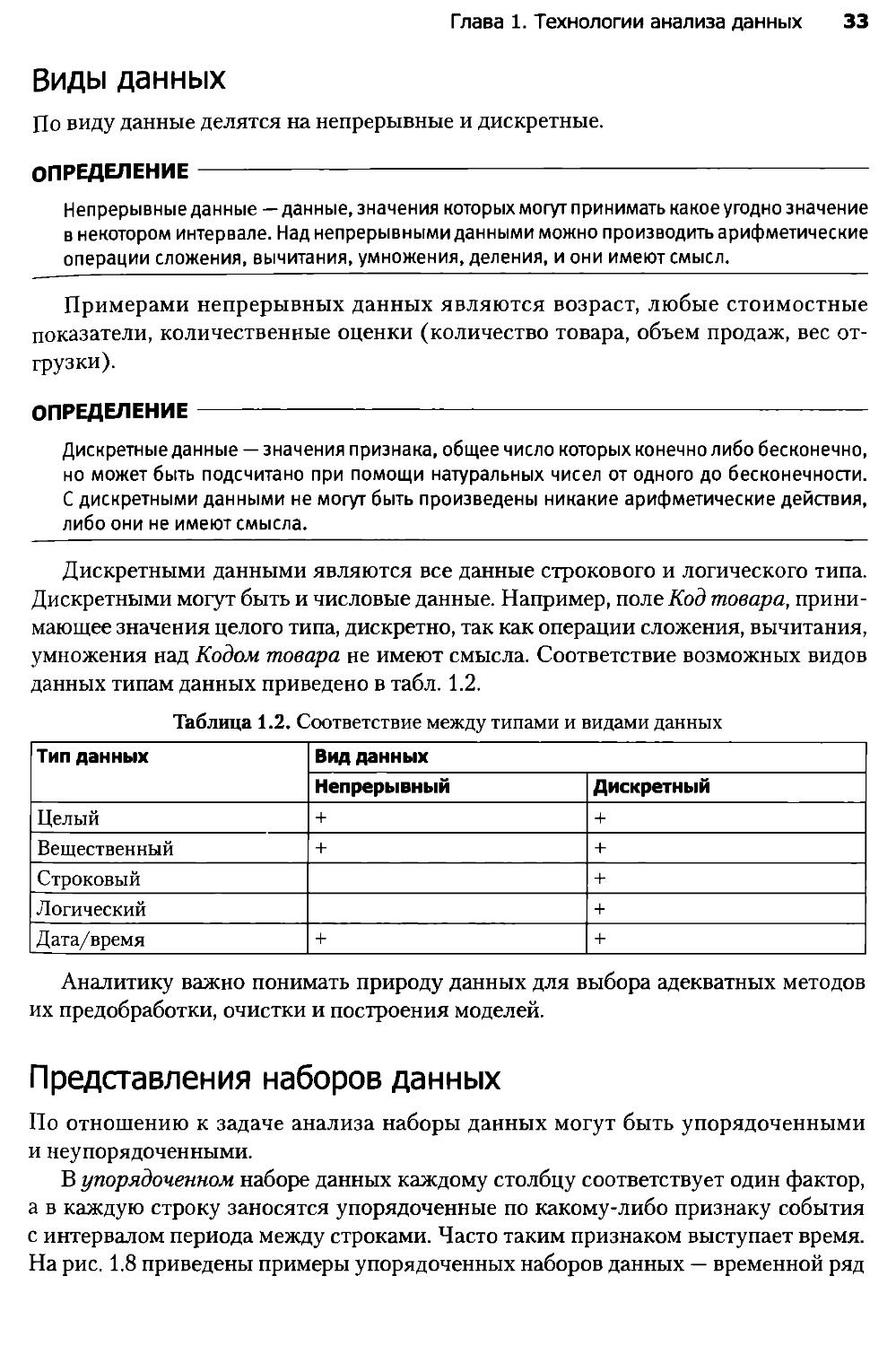

Таблица 1.2. Соответствие между типами и видами данных

Тип данных Вид данных

Непрерывный Дискретный

Целый + +

Вещественный + +

Строковый +

Логический +

Дата/время + +

Аналитику важно понимать природу данных для выбора адекватных методов

их предобработки, очистки и построения моделей.

Представления наборов данных

По отношению к задаче анализа наборы данных могут быть упорядоченными

и неупорядоченными.

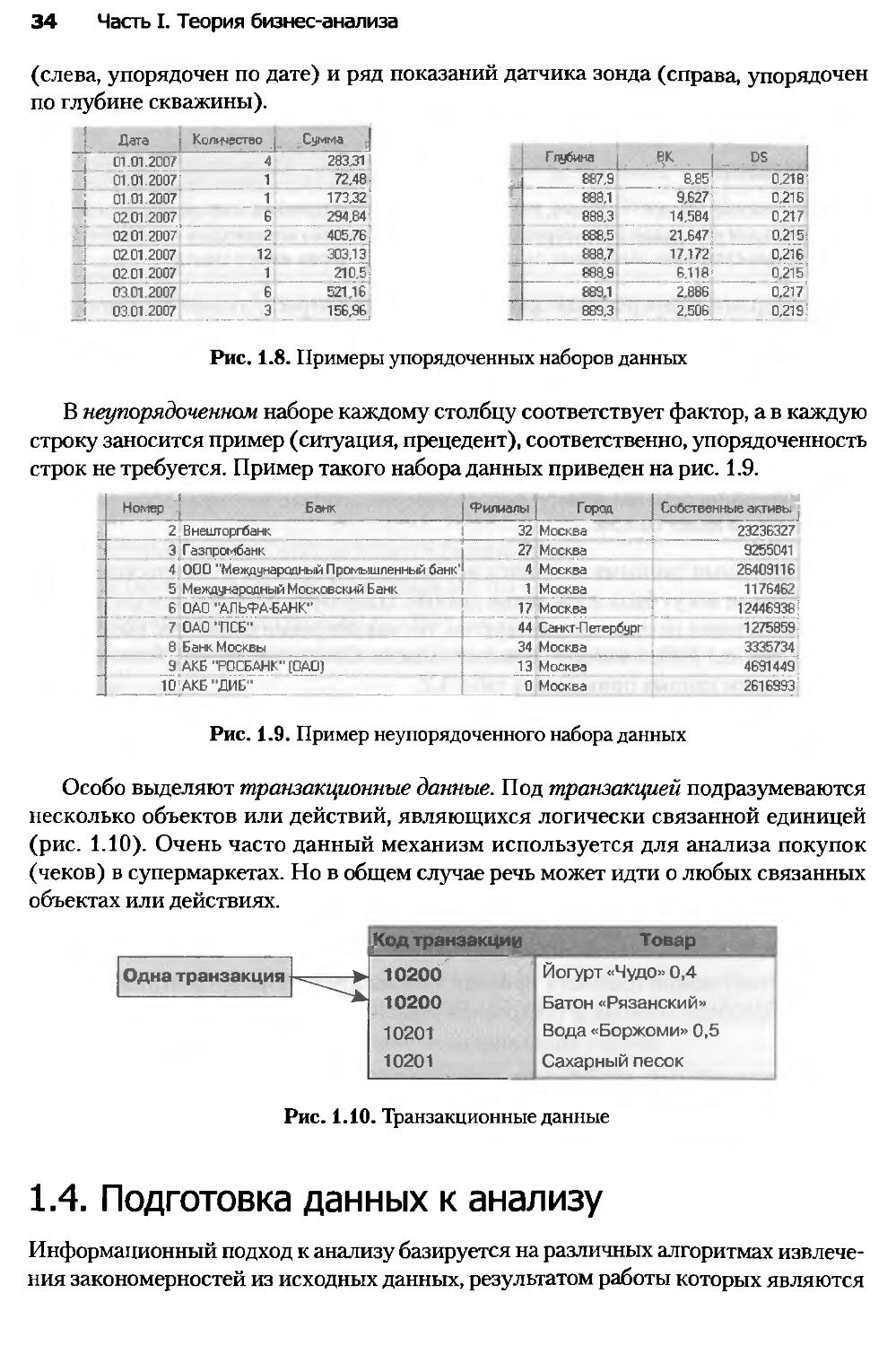

В упорядоченном наборе данных каждому столбцу соответствует один фактор,

а в каждую строку заносятся упорядоченные по какому-либо признаку события

с интервалом периода между строками. Часто таким признаком выступает время.

На рис. 1.8 приведены примеры упорядоченных наборов данных — временной ряд

34 Часть I. Теория бизнес-анализа

(слева, упорядочен по дате) и ряд показаний датчика зонда (справа, упорядочен

по глубине скважины).

i Дата Количество |; Сумма

j 01.01.2007 | 01.01 2007 4 283 31 Глубина > i DS

1 72,48 887,9 8.65 0,218 ‘

j 01.01 2007 1 173,32' 688.1 9.627 0.216

”1 02.01.2007 6 294,84 888,3 14,584 0,217

| 02 01 2007 2 405,76: 888,5 21 647! 0.215:

j 02.01.2007 12 303.1 з] 688.7 17.172 0,216

,j 02.01.2007 1 210,5; 688.9 6,118’ 0.215

j 03.01.2007 6 52116 889,1 2,886 0,217

,j 03.01.2007 3 <56.96.. _ 889,3 2.506 0,2191

Рис. 1.8. Примеры упорядоченных наборов данных

В неупорядоченном наборе каждому столбцу соответствует фактор, а в каждую

строку заносится пример (ситуация, прецедент), соответственно, упорядоченность

строк не требуется. Пример такого набора данных приведен на рис. 1.9.

Номер ’ Банк Филиалы | Город Собственные активы

2. Внешторгбанк 32 Москва 2323632’

3 Газпромбанк 27 Москва 925504I

4 ООО "Международный Промышленный банк' 4 Москва 26409116

5 Международный Московский Банк I 1 Москва 1176462

6 ОАО "АЛЬФАБАНК 17 Москва 12446936

7 ОАО "ПСБ" 44 Санкт-Петербург 1275859

8 Банк Москвы 34 Москва 3335734

9 АКБ "РОСБАНК" (ОАО) 13 Москва 46914^9

10 АКБ ДНЕ 0 Москва 2616993

Рис. 1.9. Пример неупорядоченного набора данных

Особо выделяют транзакционные данные. Под транзакцией подразумеваются

несколько объектов или действий, являющихся логически связанной единицей

(рис. 1.10). Очень часто данный механизм используется для анализа покупок

(чеков) в супермаркетах. Но в общем случае речь может идти о любых связанных

объектах или действиях.

Ко/ ранзакщ-.г. Товар

Одна транзакция 1020v 10200 10201 10201 Йогурт «Чудо» 0,4 Батон «Рязанский» Вода «Боржоми» 0,5 Сахарный песок

Рис. 1.10. Транзакционные данные

1.4. Подготовка данных к анализу

Информационный подход к анализу базируется на различных алгоритмах извлече-

ния закономерностей из исходных данных, результатом работы которых являются

Глава 1. Технологии анализа данных 35

модели. Таких алгоритмов довольно много, но они не способны гарантировать

качественное решение. Никакой, даже весьма изощренный, метод сам по себе не

даст хорошего результата, так как критически важным является качество исходных

данных. Чаще всего именно оно становится причиной неудачи. Несмотря на то

что существуют специальные методы очистки данных, понимание и соблюдение

принципов сбора и подготовки данных значительно облегчит построение моделей

и позволит получить хорошие результаты.

Особенности данных, накопленных в компаниях

Данные, которые накапливают предприятия и организации в базах данных и про-

чих источниках (так называемые бизнес-данные), имеют свои особенности. Рас-

смотрим их.

Бизнес-данные редко накапливаются специально для решения задач анализа.

Предприятия и организации собирают данные для коммерческих целей: ведения

учета, проведения финансового анализа, составления отчетности, принятия реше-

ний и т. п. Этим бизнес-данные отличаются от экспериментальных данных, которые

собираются для исследовательских целей. Основными потребителями бизнес-дан-

ных обычно являются лица, принимающие решения в компаниях.

Бизнес-данные, как правило, содержат ошибки, аномалии, противоречия и про-

пуски. Это следствие того, что компании не собирают данные с целью анализа.

В них появляются ошибки различной природы, что снижает качество данных.

С точки зрения анализа объемы хранимых данных очень велики. Современные

базы данных содержат мегабайты и гигабайты информации. Для ресурсоемких

алгоритмов анализа данных таблицу объемом 50 тыс. записей можно считать боль-

шой, поэтому при построении моделей важно применять процедуры сэмплинга,

сокращения записей и отбора информативных признаков либо использовать спе-

циальные масштабируемые алгоритмы, способные работать на больших наборах

данных.

Отмеченные особенности бизнес-данных влияют как на сам процесс анализа,

так и на подготовку и систематизацию данных.

Формализация данных

При сборе данных нужно придерживаться следующих принципов.

1. Абстрагироваться от существующих информационных систем и имеющихся

в наличии данных. Большие объемы накопленных данных совершенно не гово-

рят о том, что их достаточно для анализа в конкретной компании. Необходимо

отталкиваться от задачи и подбирать данные для ее решения, а не брать име-

ющуюся информацию. К примеру, при построении моделей прогноза продаж

опрос экспертов показал, что на спрос очень влияет цветовая характеристика

товара. Анализ имеющихся данных продемонстрировал, что информация о цве-

те товарной позиции отсутствует в учетной системе. Значит, нужно каким-то

ль часть I. Теория бизнес-анализа

образом добавить эти данные, иначе не стоит рассчитывать на хороший резуль-

тат использования моделей.

2. Описать все факторы, потенциально влияющие на анализируемый процесс/

объект. Основным инструментом здесь становится опрос экспертов и людей,

непосредственно владеющих проблемной ситуацией. Необходимо максимально

использовать знания экспертов о предметной области и, полагаясь на здравый

смысл, постараться собрать и систематизировать максимум возможных пред-

положений и гипотез.

3. Экспертно оценить значимость каждого фактора. Эта оценка не является

окончательной, она будет отправной точкой. В процессе анализа вполне может

выясниться, что фактор, который эксперты посчитали очень важным, таковым

не является, и наоборот, незначимый, с их точки зрения, фактор может оказы-

вать значительное влияние на результат.

4. Определить способ представления информации — число, дата, да/нет, категория

(то есть тип данных). Определить способ представления, то есть формализовать

некоторые данные, просто. Например, объем продаж в рублях — это определен-

ное число. Но довольно часто бывает непонятно, как представить фактор. Чаще

всего такие проблемы возникают с качественными характеристиками. Напри-

мер, на объемы продаж влияет качество товара. Качество — сложное понятие,

но если этот показатель действительно важен, то нужно придумать способ его

формализации. Скажем, качество можно определять по количеству брака на

тысячу единиц продукции либо оценивать экспертно, разбив на несколько ка-

тегорий — отлично/хорошо/удовлетворительно/плохо.

5. Собрать все легкодоступные факторы. Они содержатся в первую очередь в источ-

никах структурированной информации — учетных системах, базах данных и т. п.

6. Обязательно собрать наиболее значимые, с точки зрения экспертов, факторы.

Вполне возможно, что без них не удастся построить качественную модель.

7. Оценить сложность и стоимость сбора средних и наименее важных по значимо-

сти факторов. Некоторые данные легкодоступны, их можно извлечь из суще-

ствующих информационных систем. Но есть информация, которую непросто

собрать, например сведения о конкурентах, поэтому необходимо оценить, во что

обойдется сбор данных. Сбор данных не является самоцелью. Если информацию

получить легко, то, естественно, нужно ее собрать. Если сложно, то необходимо

соизмерить затраты на ее сбор и систематизацию с ожидаемыми результатами.

Рассмотрим эти принципы на примере формализации данных при решении

задачи прогнозирования спроса. На этапе описания факторов, влияющих на про-

дажи, и выдвижения гипотез полезно составить таблицу факторов и их значимости

(табл. 1.3).

При создании подобной таблицы следуют принципам 1-3 формализации

данных. Далее необходимо определить способ представления данных и оценить

стоимость их сбора. К таблице добавятся еще два столбца (табл. 1.4). И уже после

этого можно принимать решение о том, какие факторы включать в анализ, а ка-

Глава 1. Технологии анализа данных 37

кими пренебречь. Очевидно, что все легкодоступные показатели с высокой экс-

пертной значимостью требуется включать в рассмотрение. А фактором «Качество

продукции», например, можно пренебречь: по мнению экспертов, он малозначим,

а стоимость его сбора велика.

Таблица 1.3. Факторы, влияющие на продажи, и их значимость

Фактор Экспертная оценка значимости (1-100)

Сезон 100

День недели 80

Объем продаж за предыдущие недели 100

Объем продаж за аналогичный период прошлого года 95

Рекламная кампания 60

Маркетинговые мероприятия 40

Качество продукции 30

Рейтинг бренда 25

Отклонение цены от среднерыночной 60

Наличие данного товара у конкурентов 15

Таблица 1.4. Факторы, влияющие на продажи, с оценками экспертов

Фактор Экспертная оценка значимости (1-100) Способ представления Экспертная оценка сложности получения

Сезон 100 Число Низкая

День недели 80 Дата Низкая

Объем продаж за предыдущие недели 100 Число Низкая

Объем продаж за аналогичный пе- риод прошлого года 95 Число Низкая

Рекламная кампания 60 Число Средняя

Маркетинговый бюджет 40 Число Средняя

Качество продукции 30 Строка (плохое/хо- рошее / отличное) Высокая

Рейтинг бренда 25 Строка (известный/ малоизвестный и т. д.) Средняя

Отклонение цены от среднерыночной 60 Число Средняя

Наличие данного товара у конкурентов 15 Логическое (да/нет) Средняя

38 Часть I. Теория бизнес-анализа

Методы сбора данных

Есть несколько методов сбора необходимых для анализа данных.

1. Получение из учетных систем. Обычно в учетных системах есть различные ме-

ханизмы построения отчетов и экспорта данных, поэтому извлечение нужной

информации из них чаще всего относительно несложная операция.

2. Получение данных из косвенных источников информации. О многих показателях

можно судить по косвенным признакам, и этим нужно воспользоваться. Напри-

мер, можно оценить реальное финансовое положение жителей определенного

региона следующим образом. В большинстве случаев имеется несколько това-

ров, предназначенных для выполнения одной и той же функции, но отличаю-

щихся по цене: товары для бедных, средних и богатых. Если получить отчет

о продажах товара в интересующем регионе и проанализировать пропорции,

в которых продаются товары для бедных, средних и богатых, то можно предпо-

ложить, что чем больше доля дорогих изделий из одной товарной группы, тем

более состоятельны в среднем жители данного региона.

3. Использование открытых источников. Большое количество данных присут-

ствует в таких открытых источниках, как статистические сборники, отчеты

корпораций, опубликованные результаты маркетинговых исследований

и пр.

4. Приобретение аналитических отчетов у специализированных компаний.

На рынке работает множество компаний, которые профессионально зани-

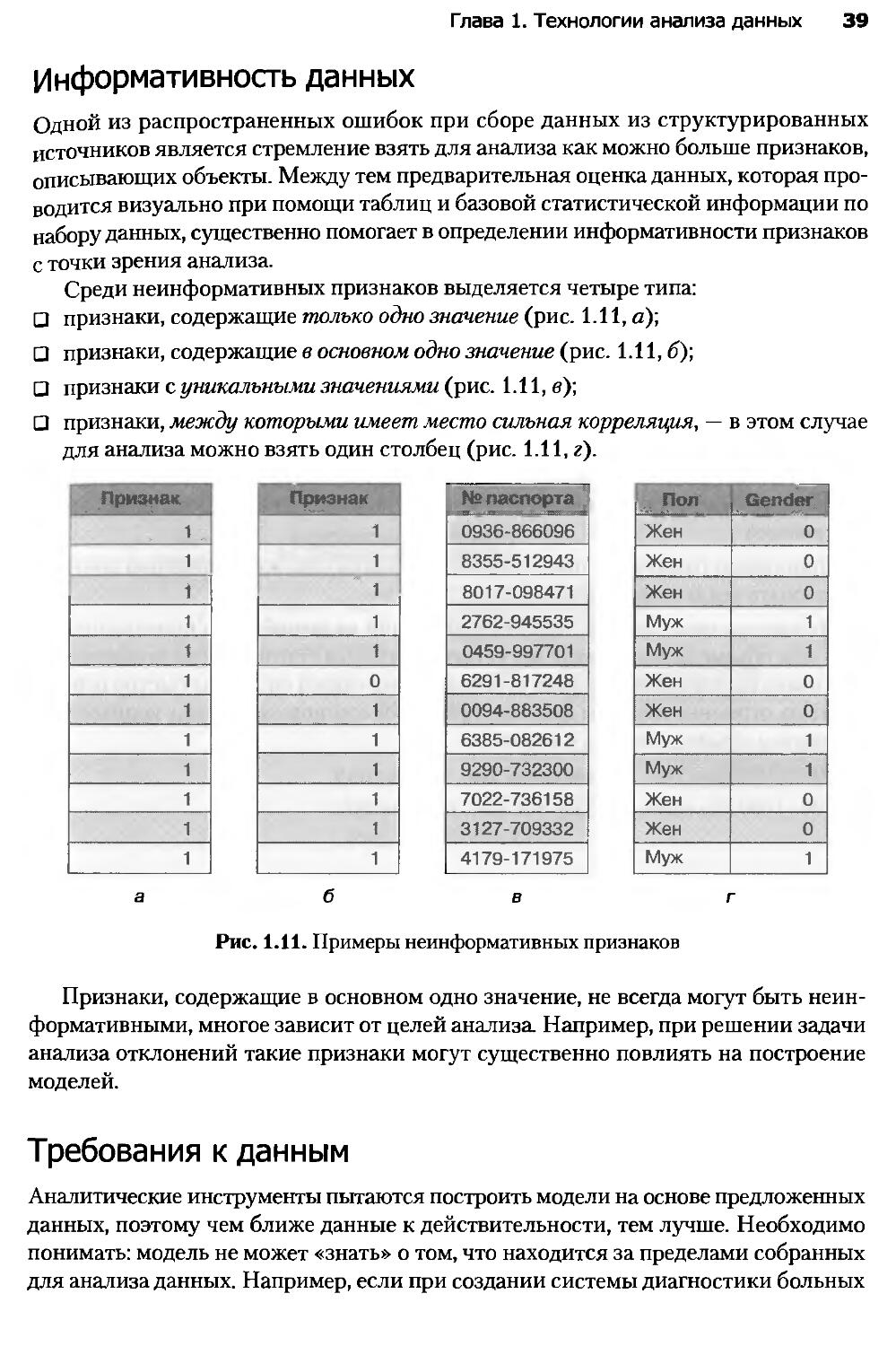

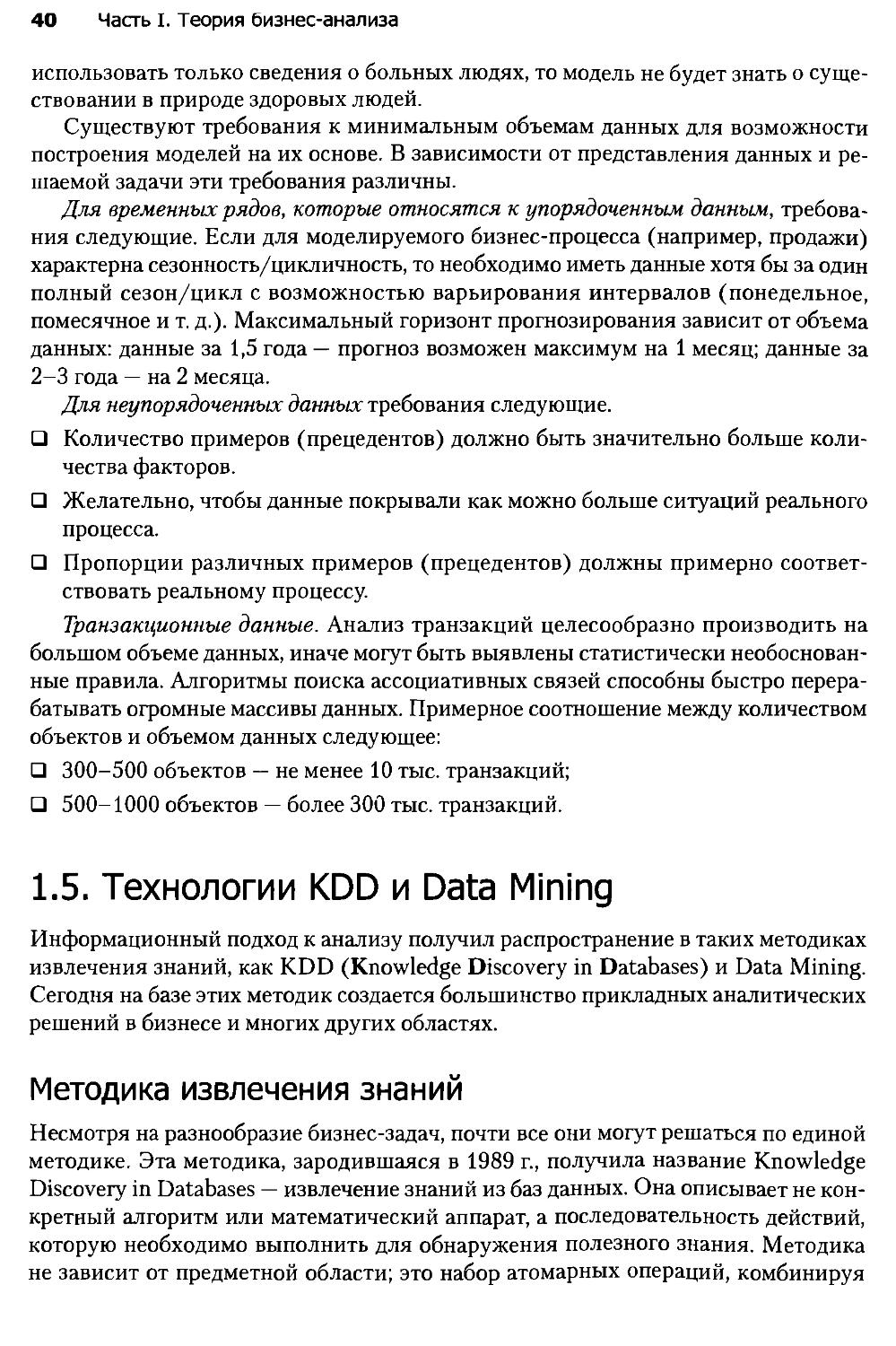

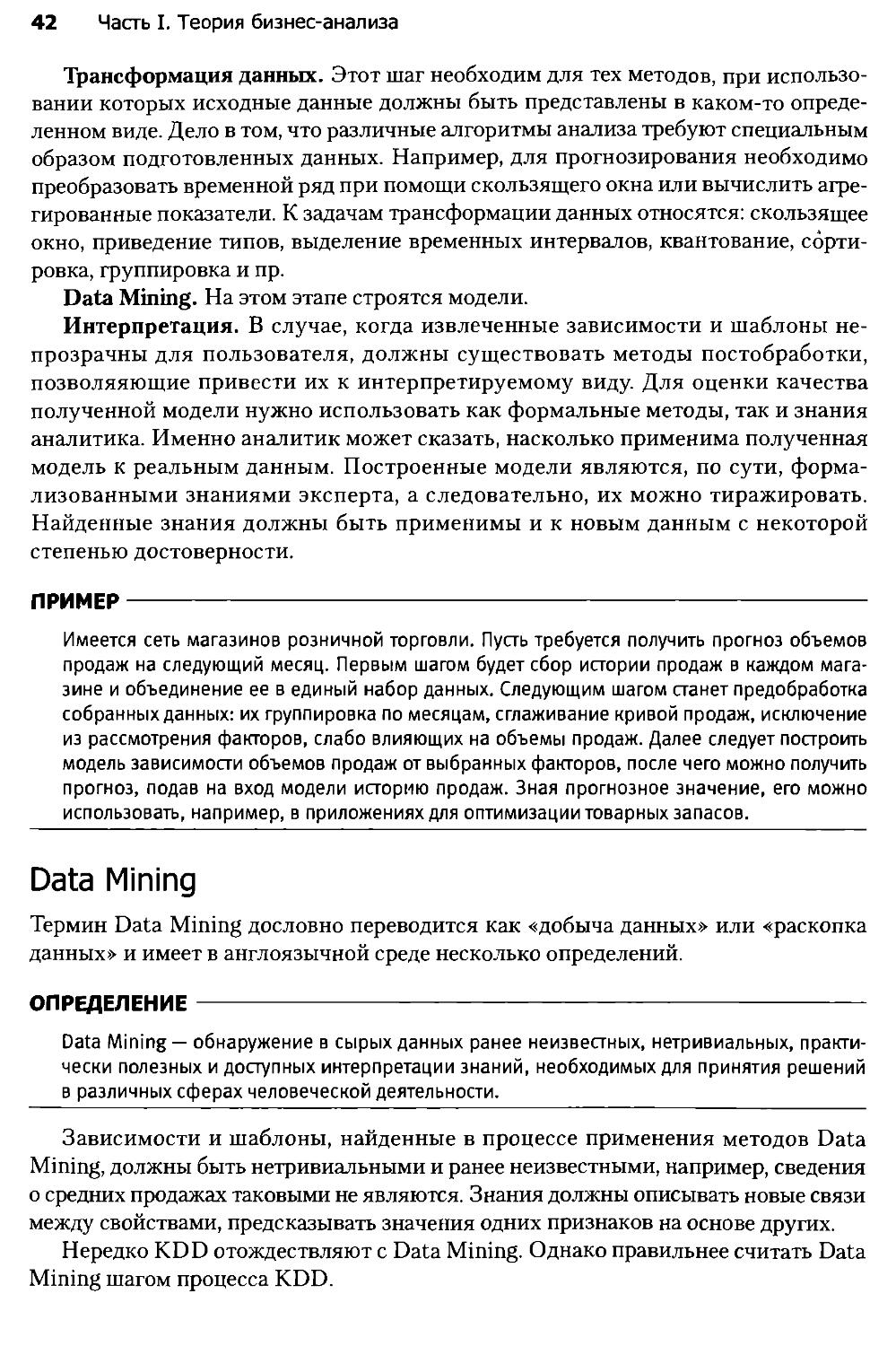

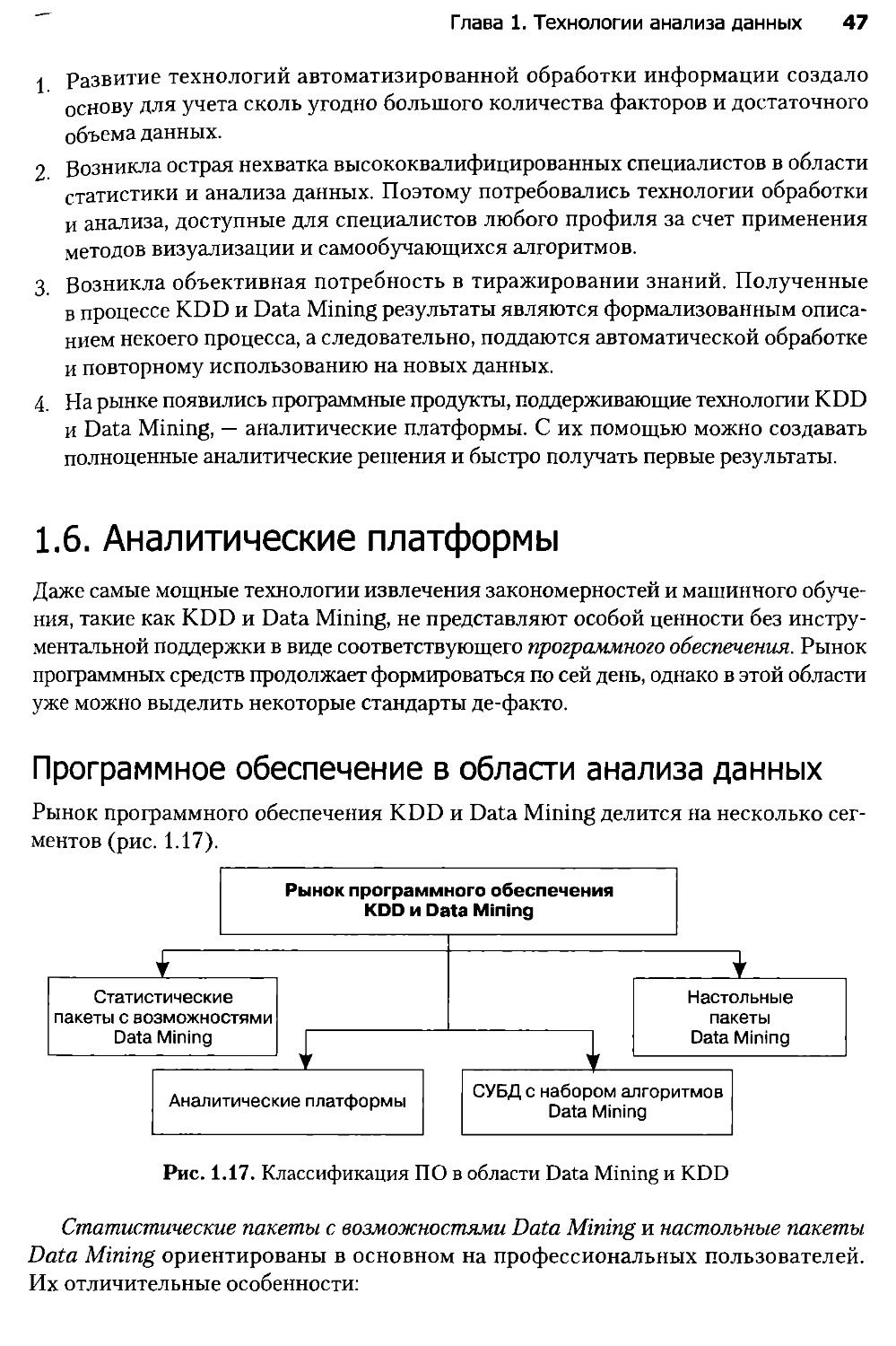

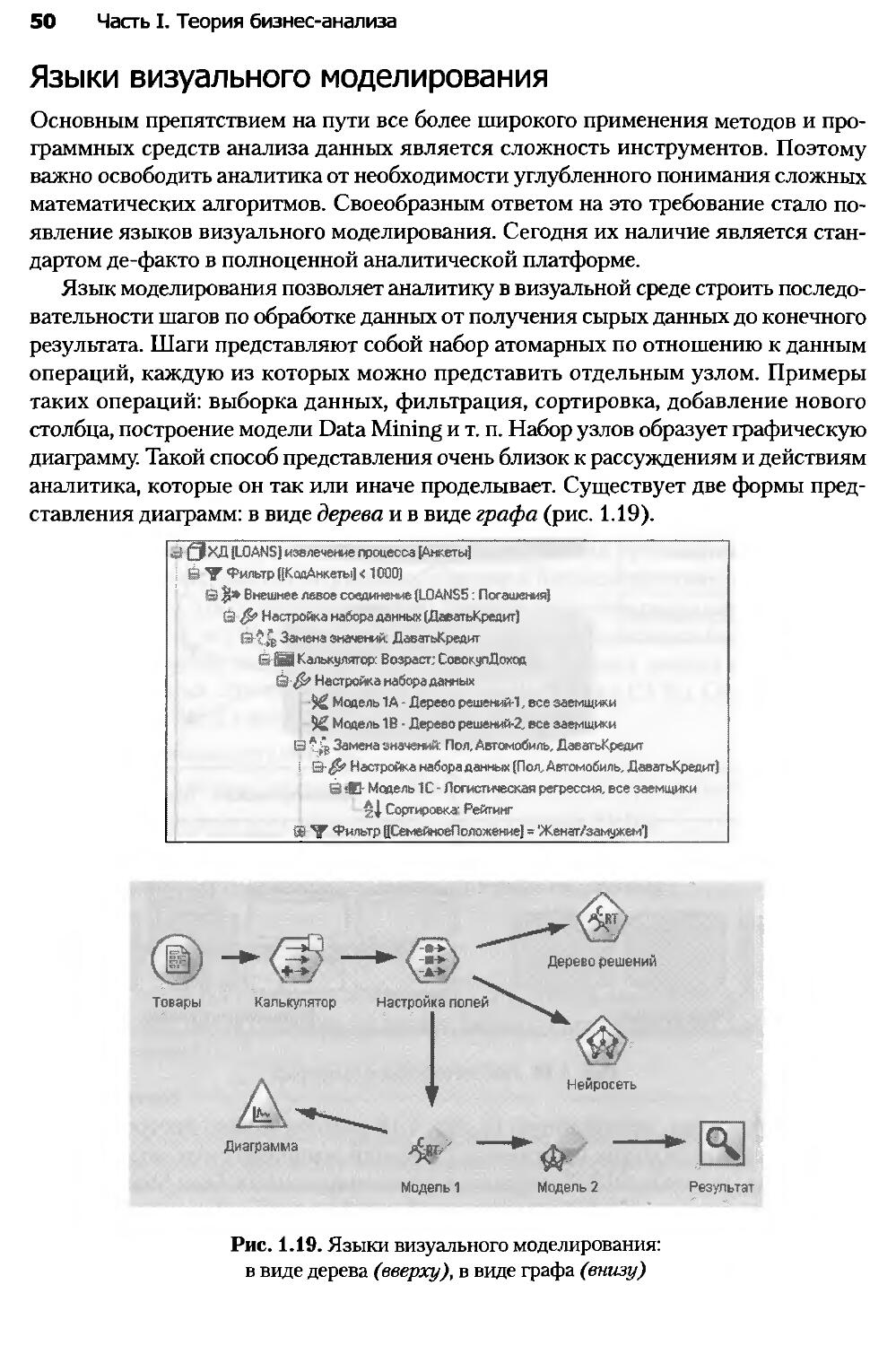

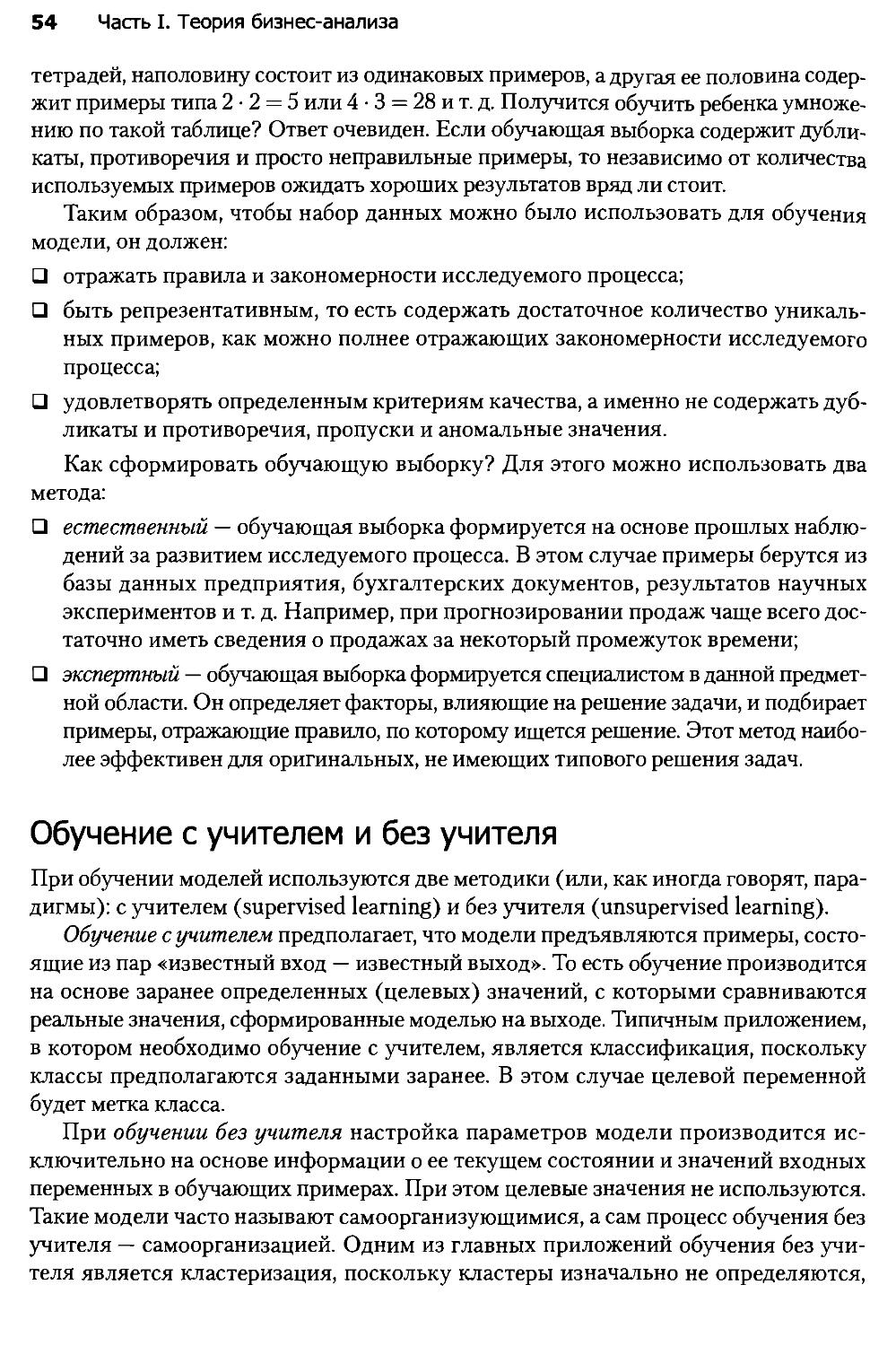

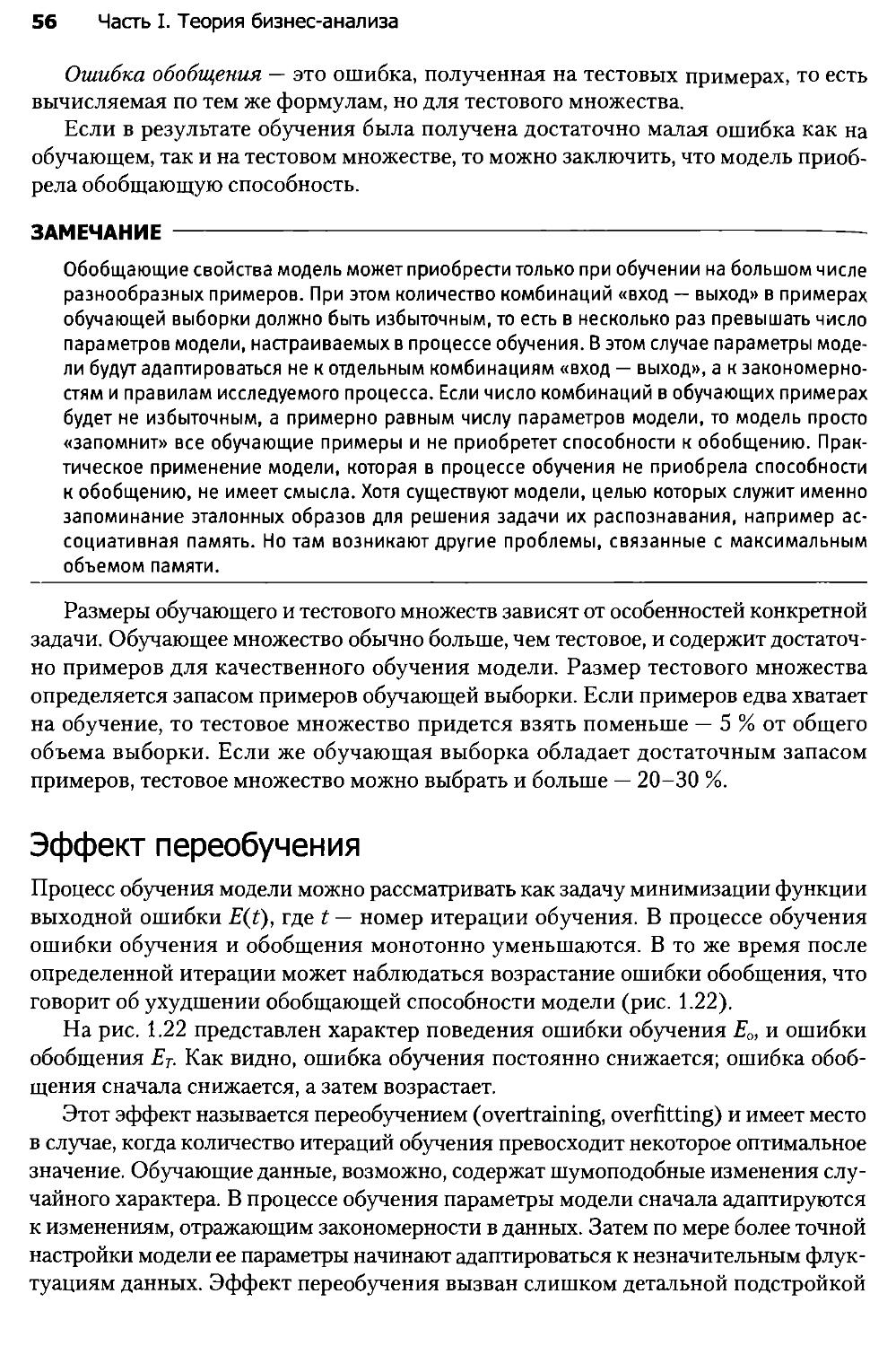

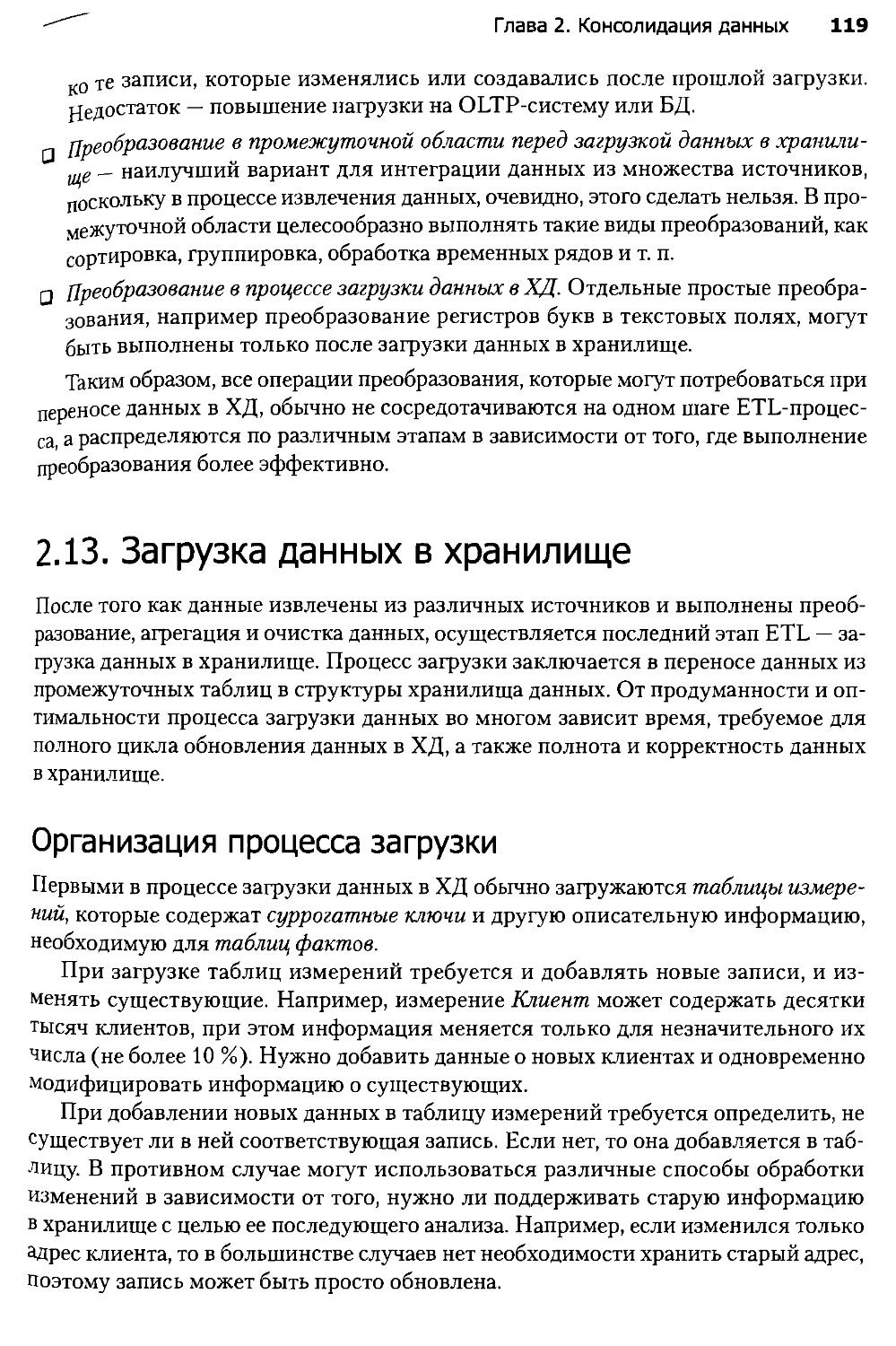

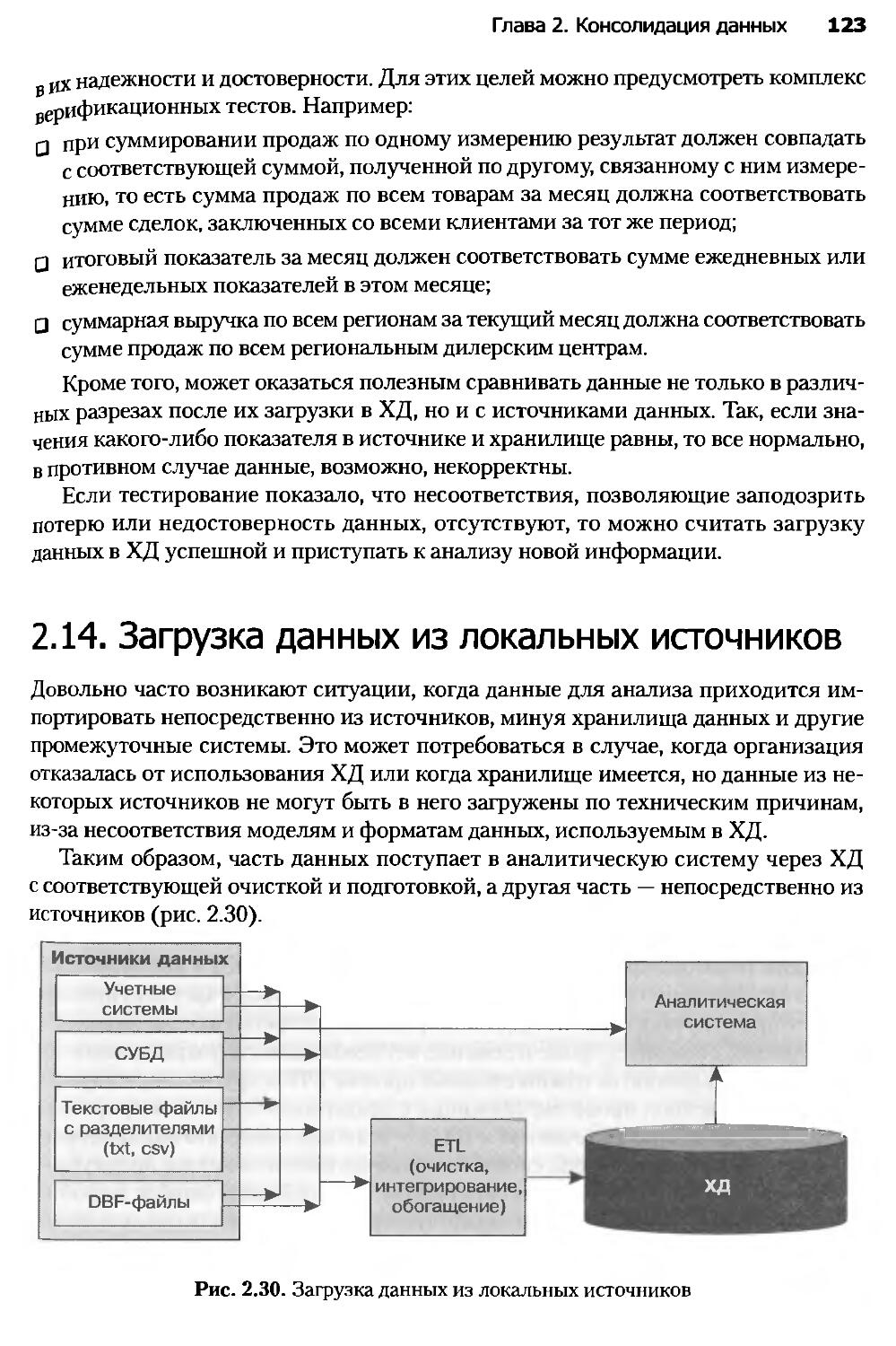

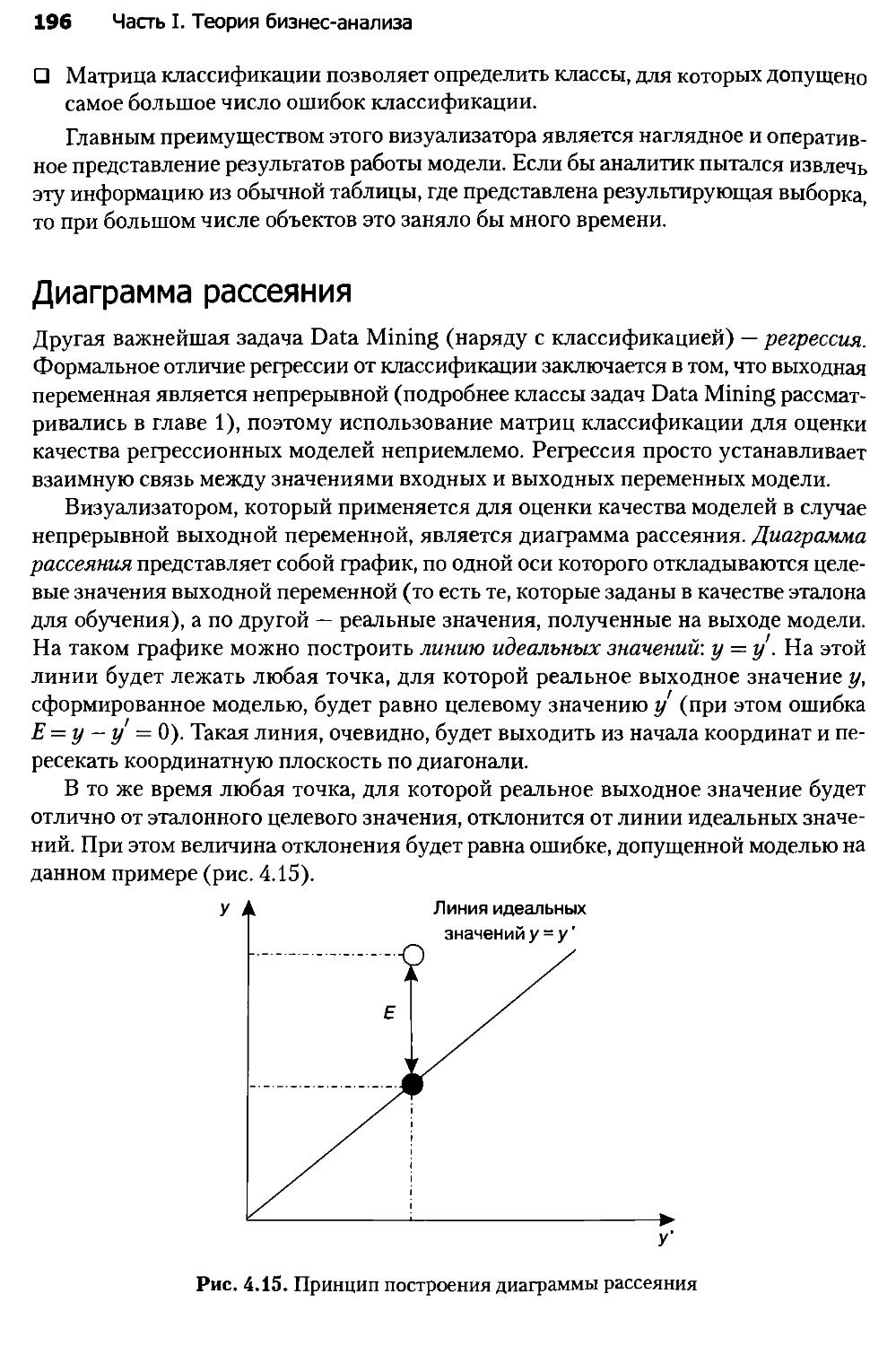

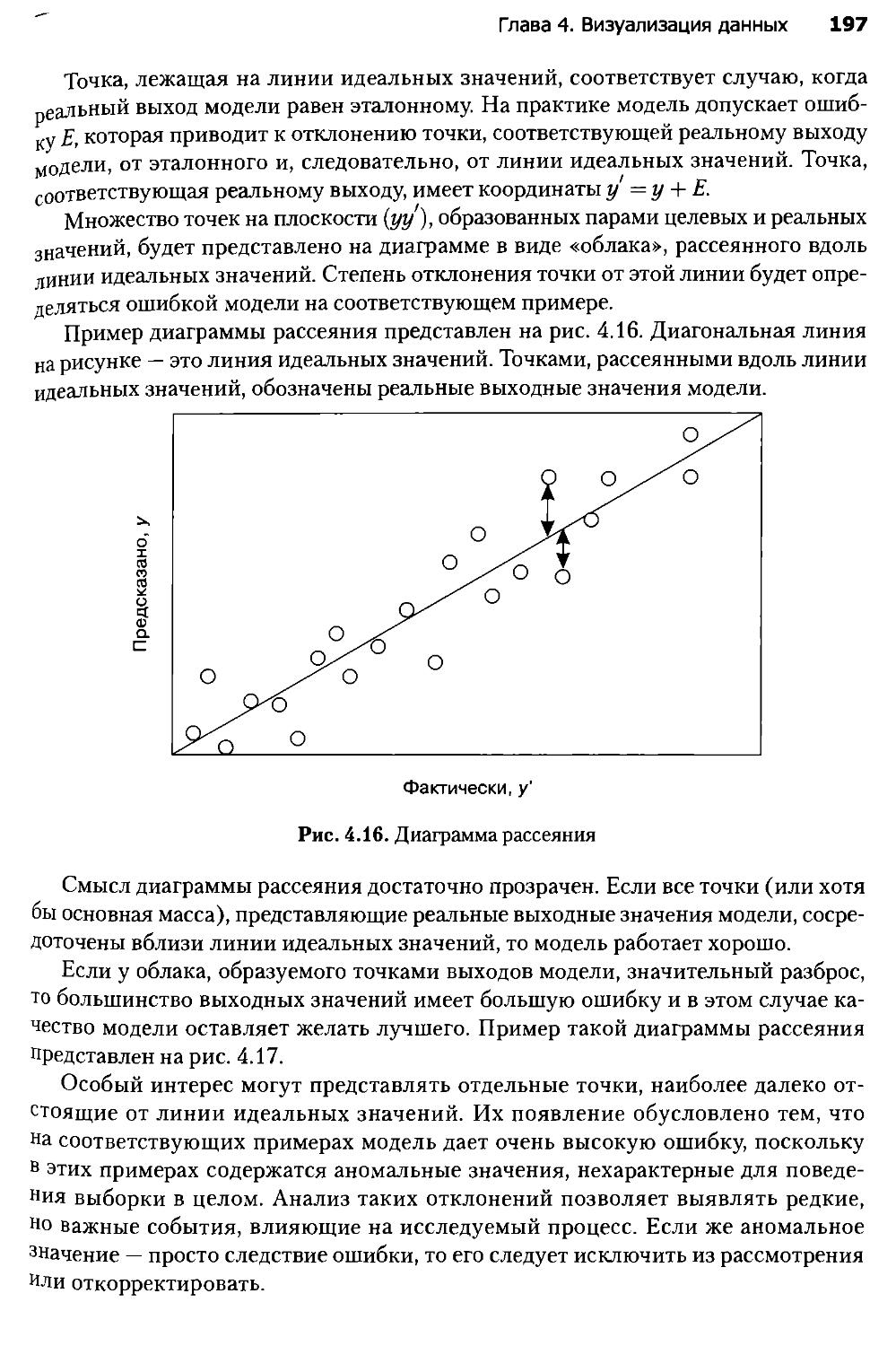

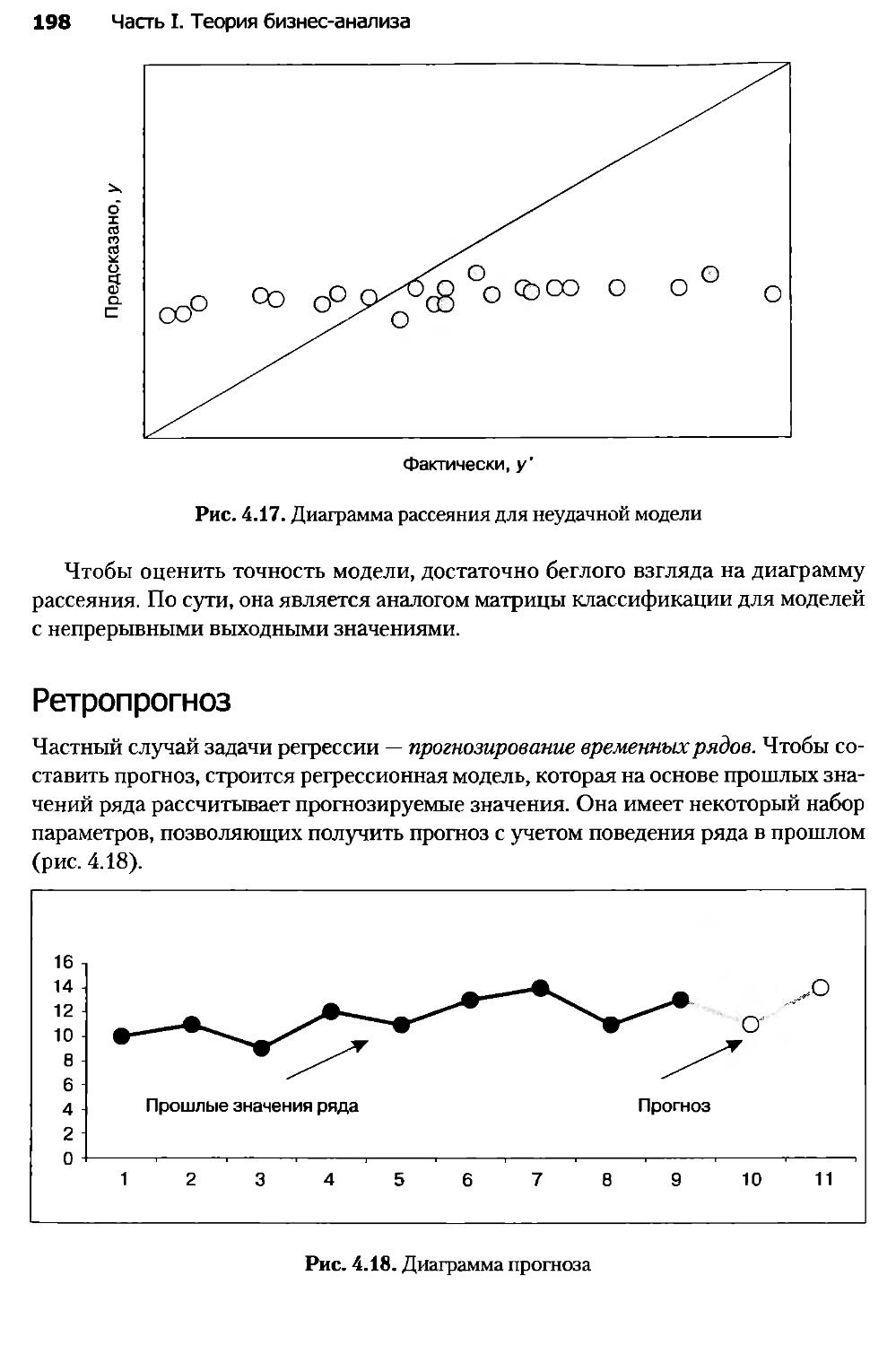

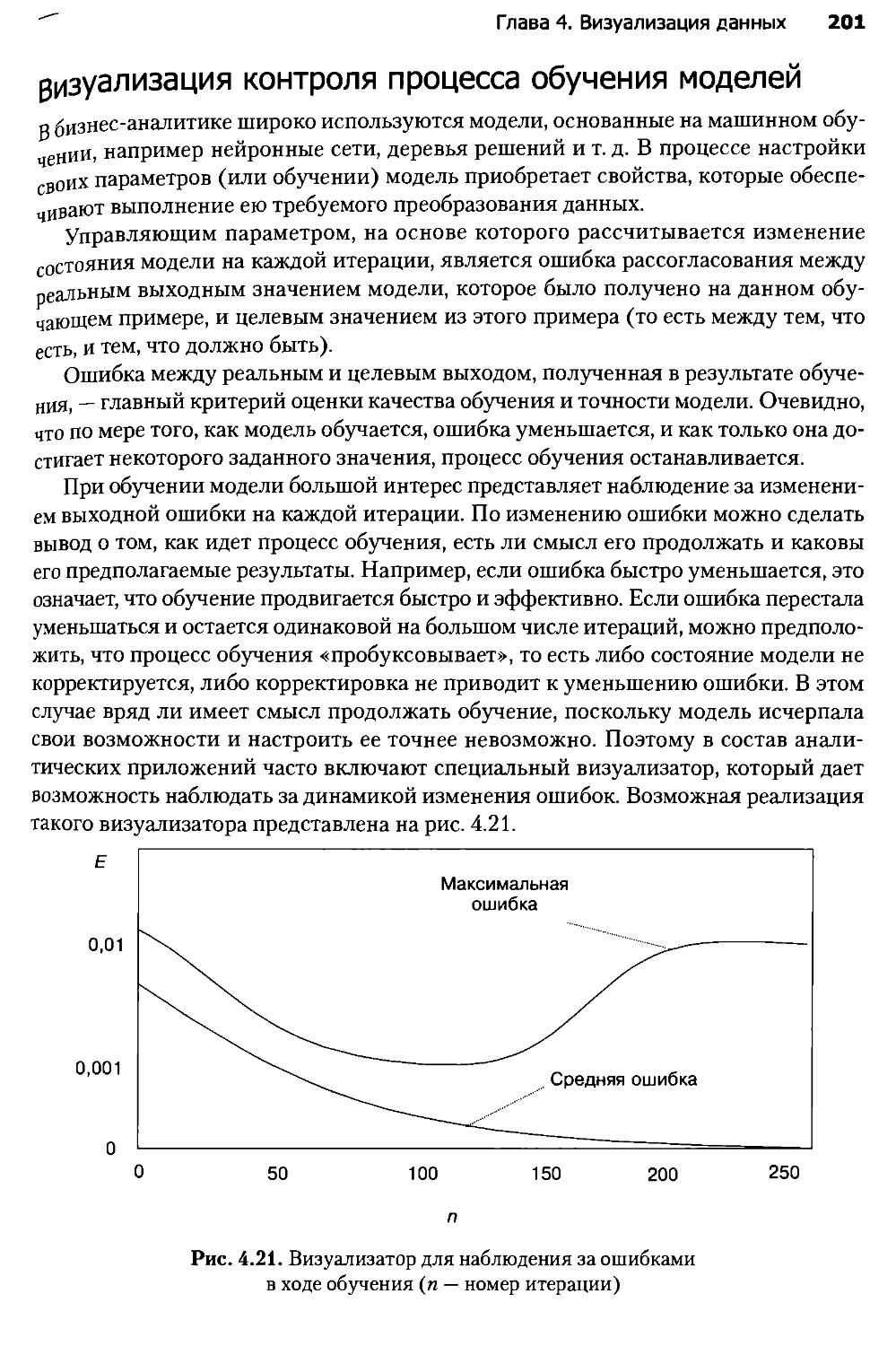

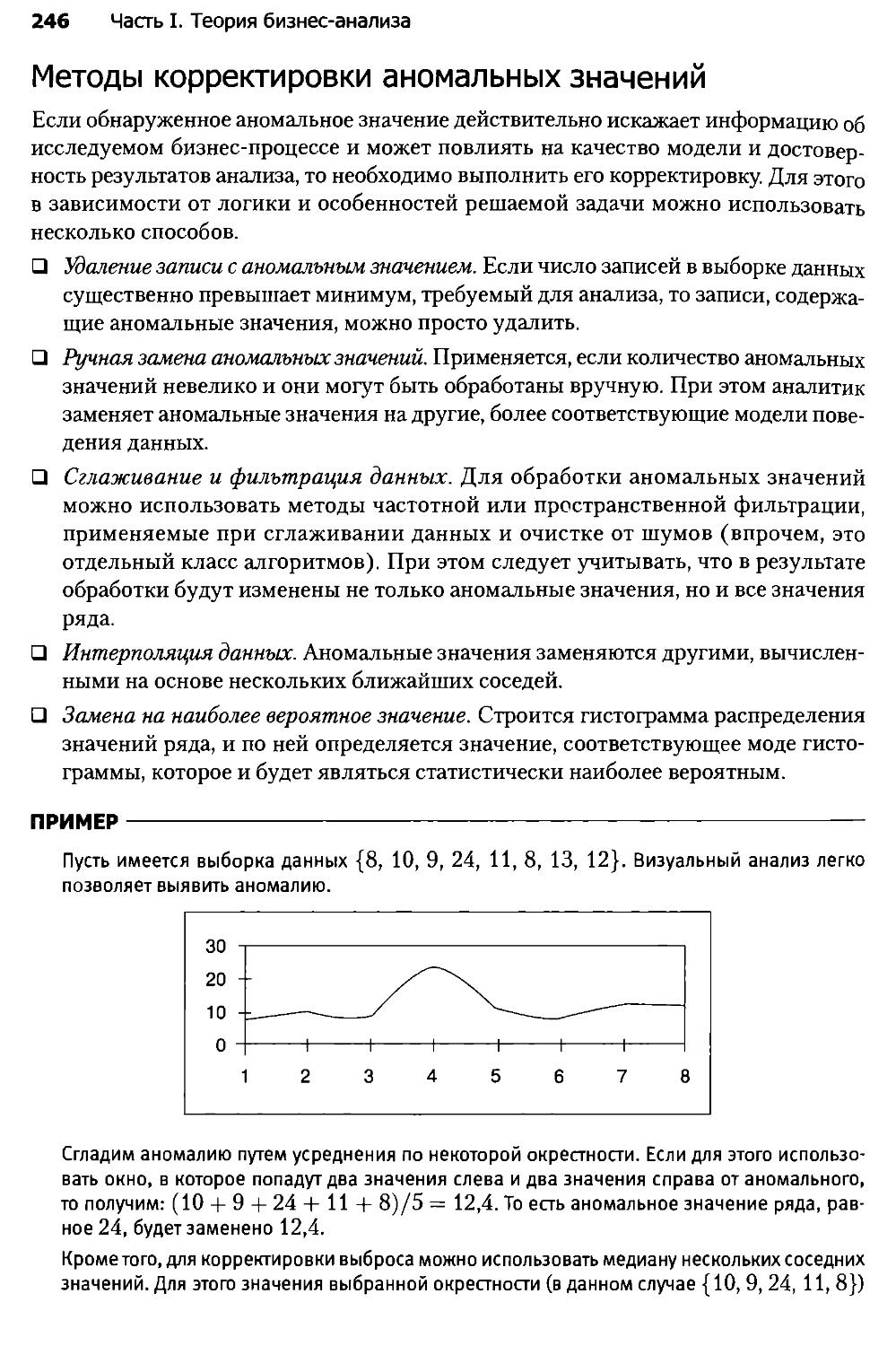

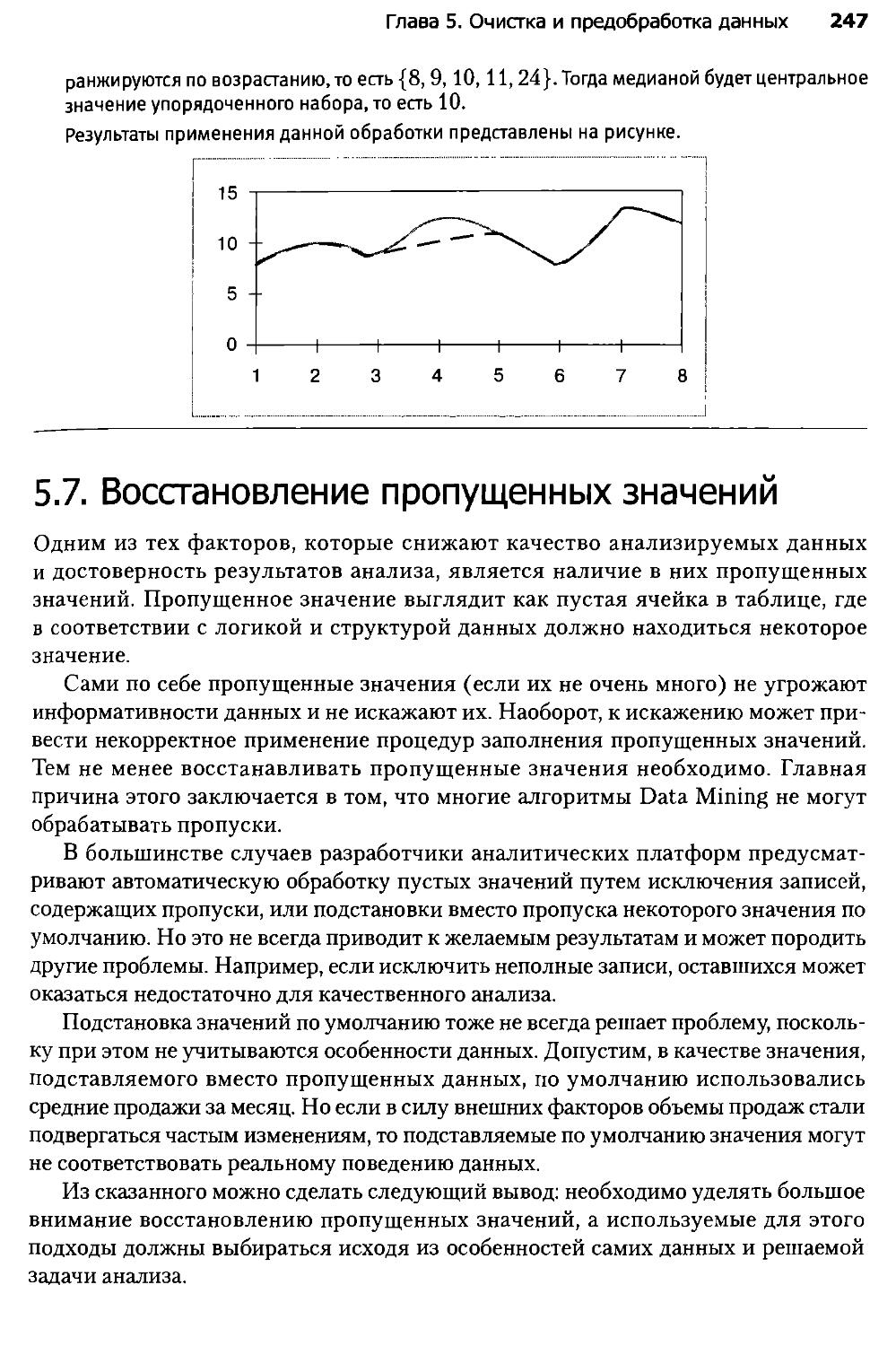

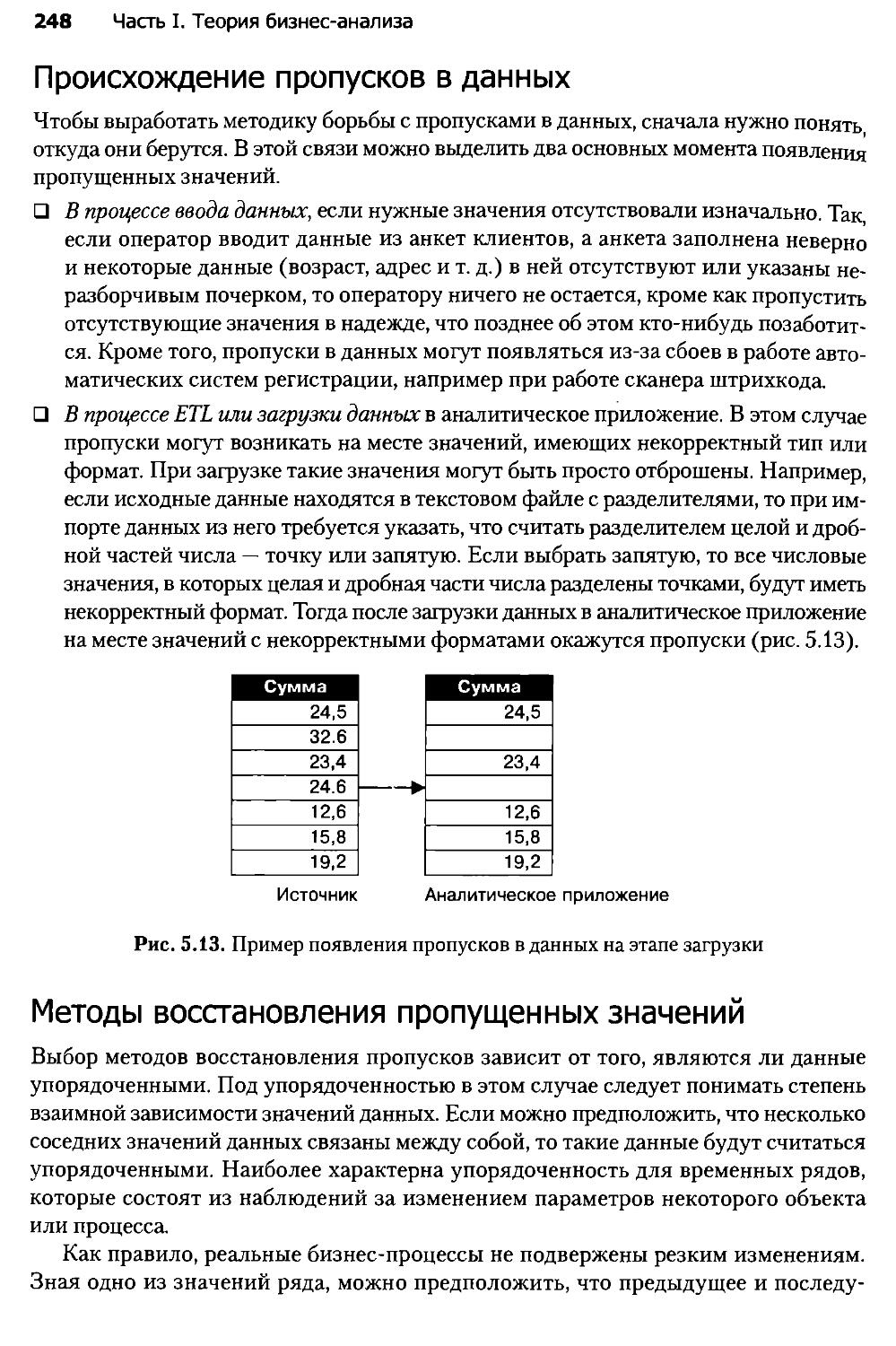

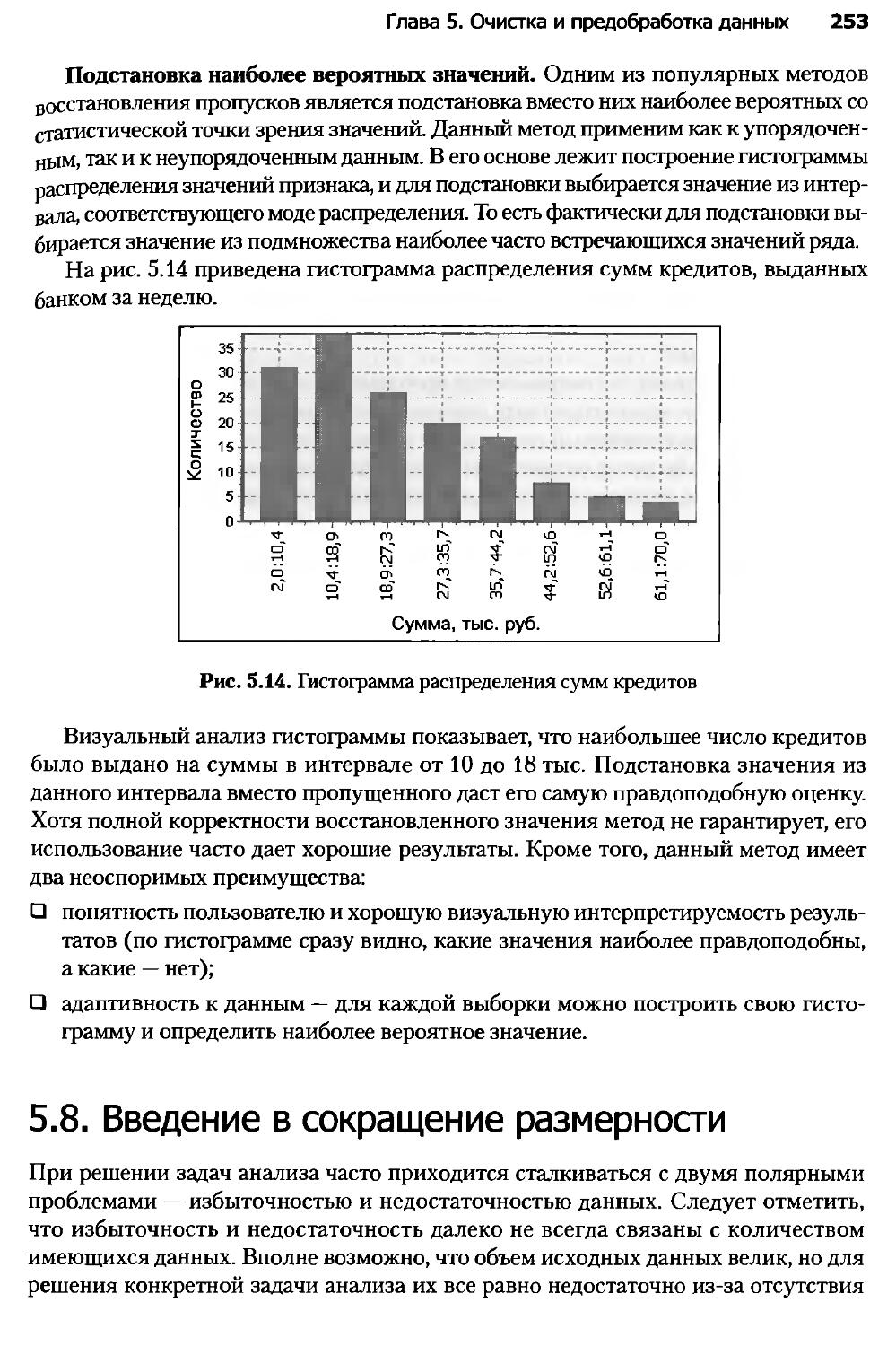

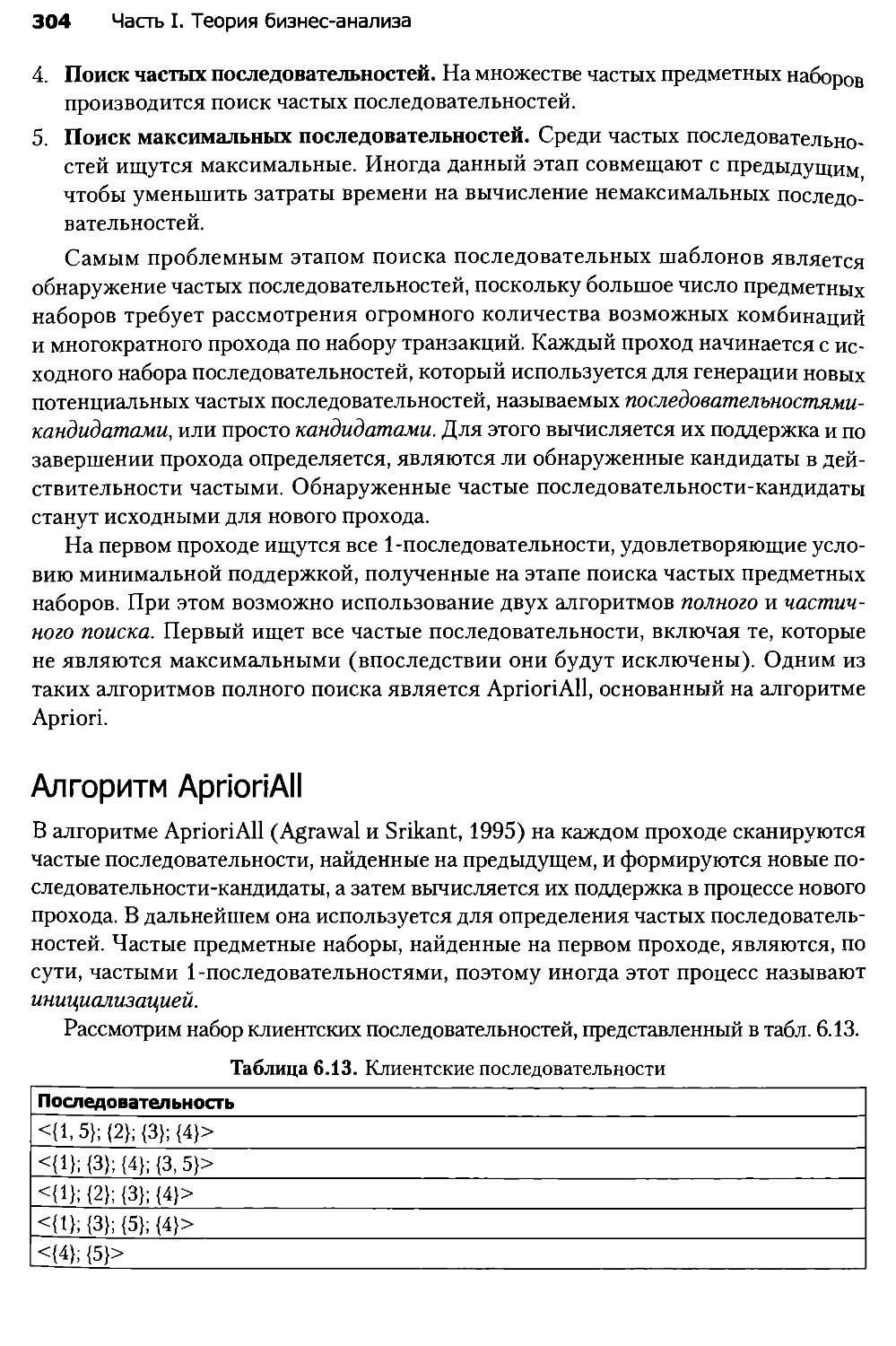

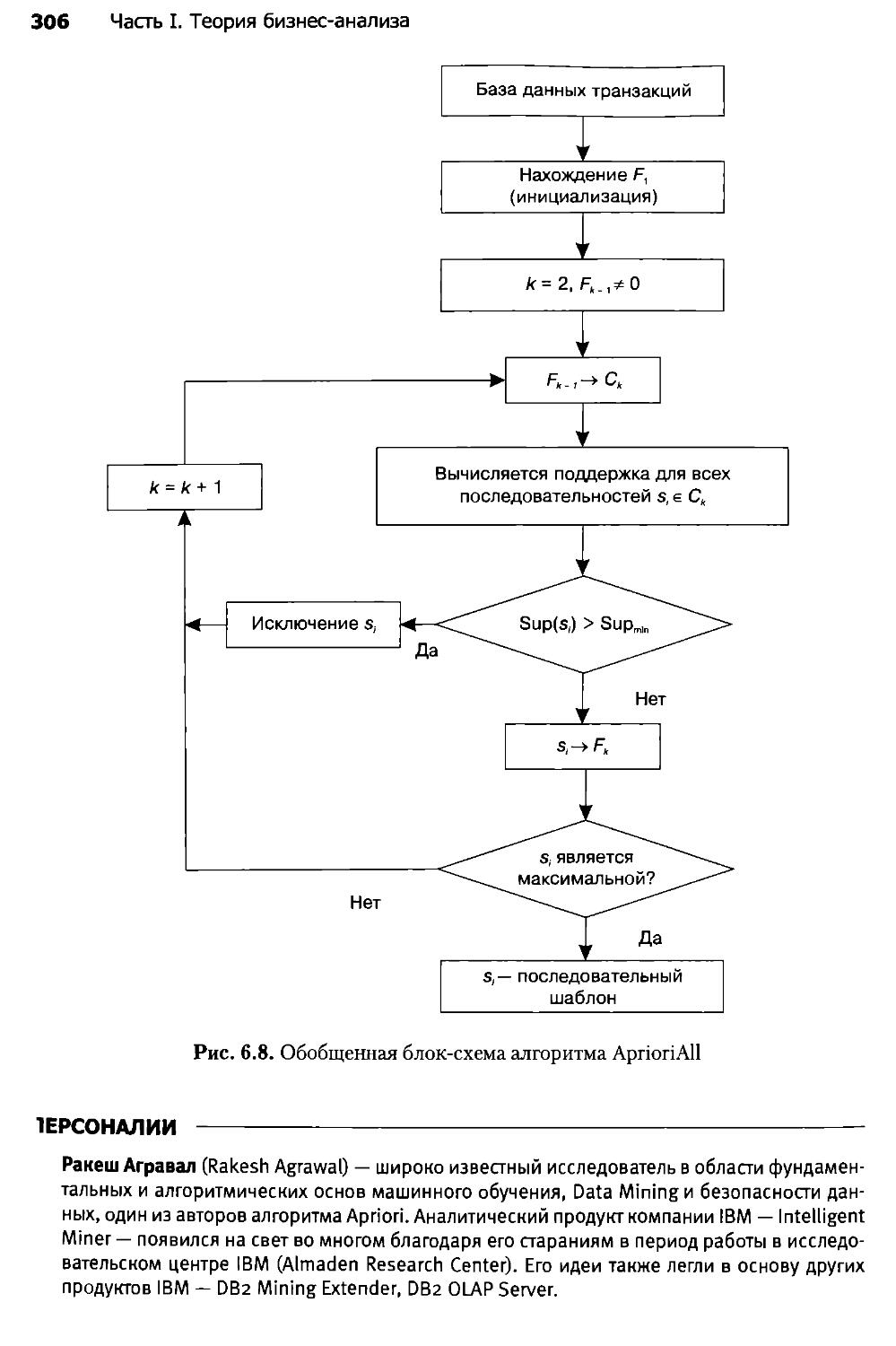

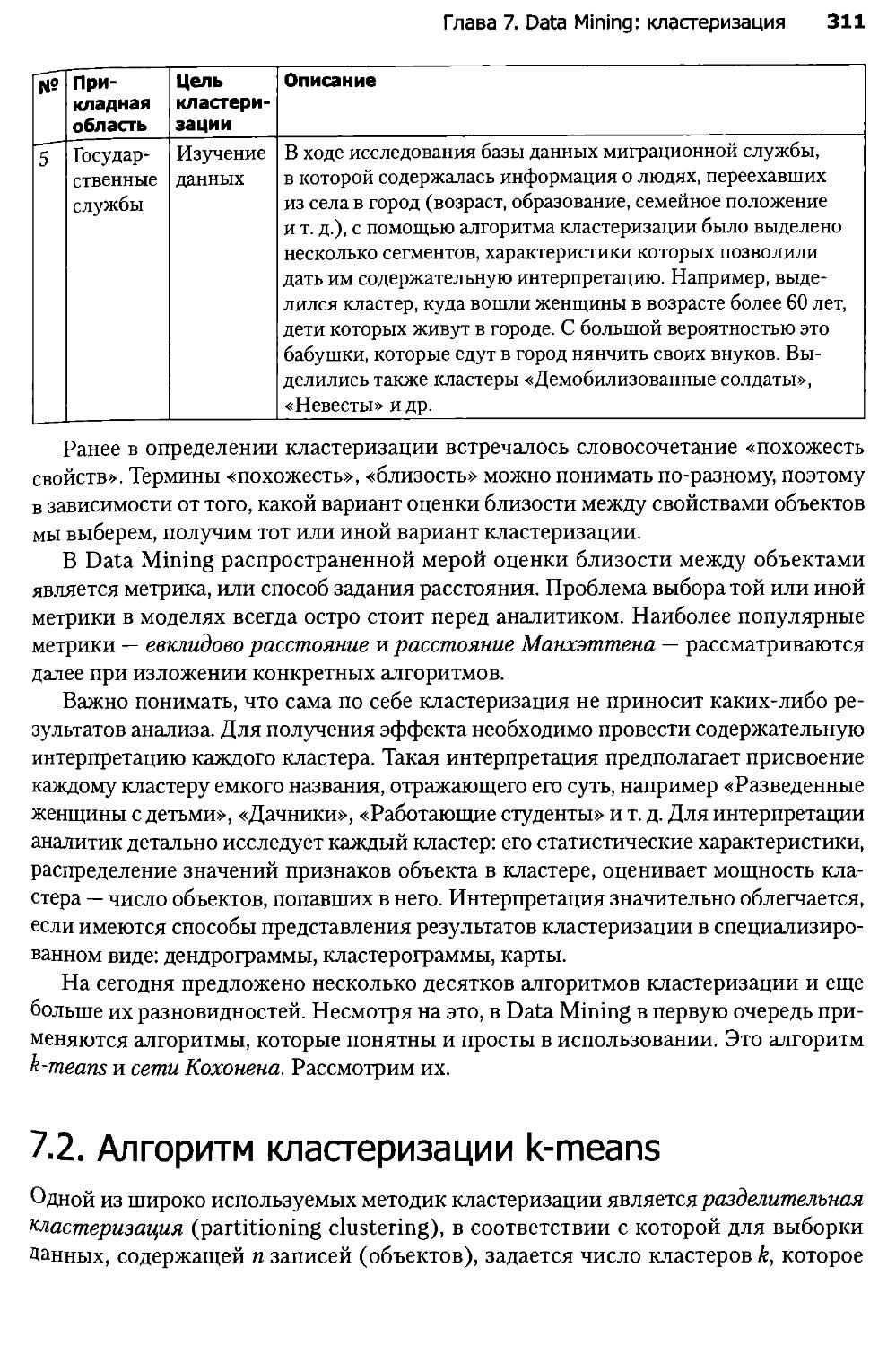

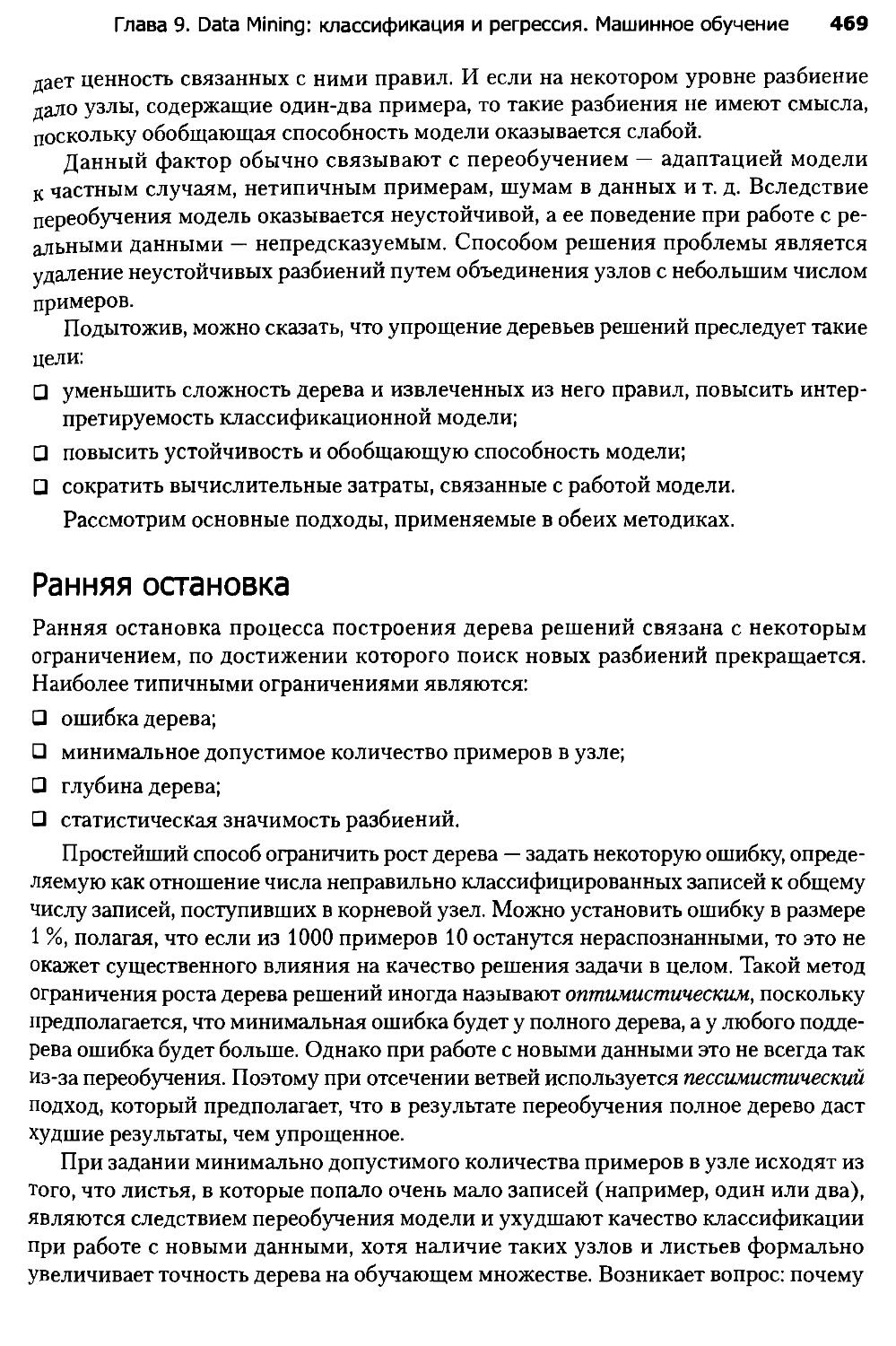

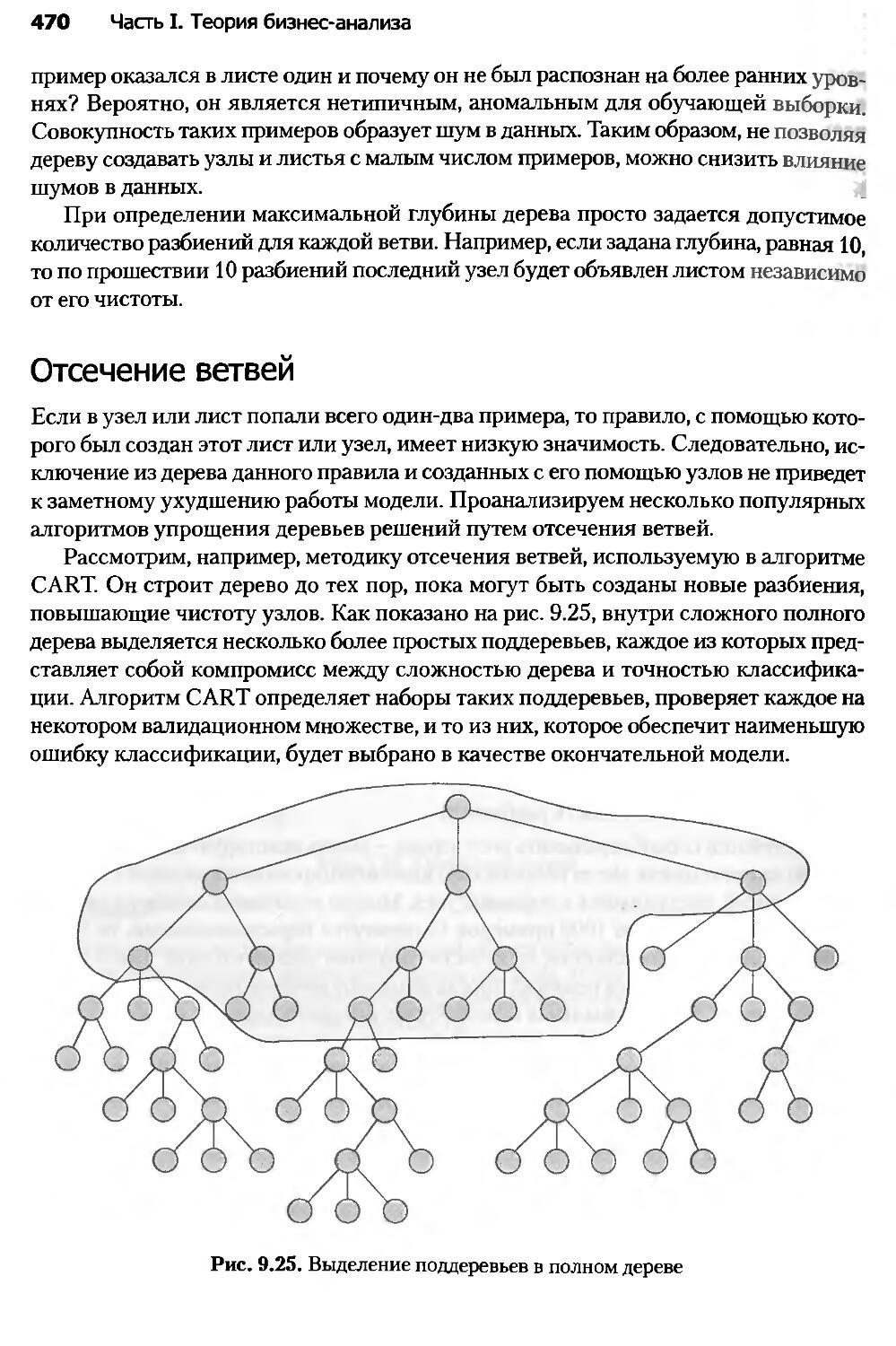

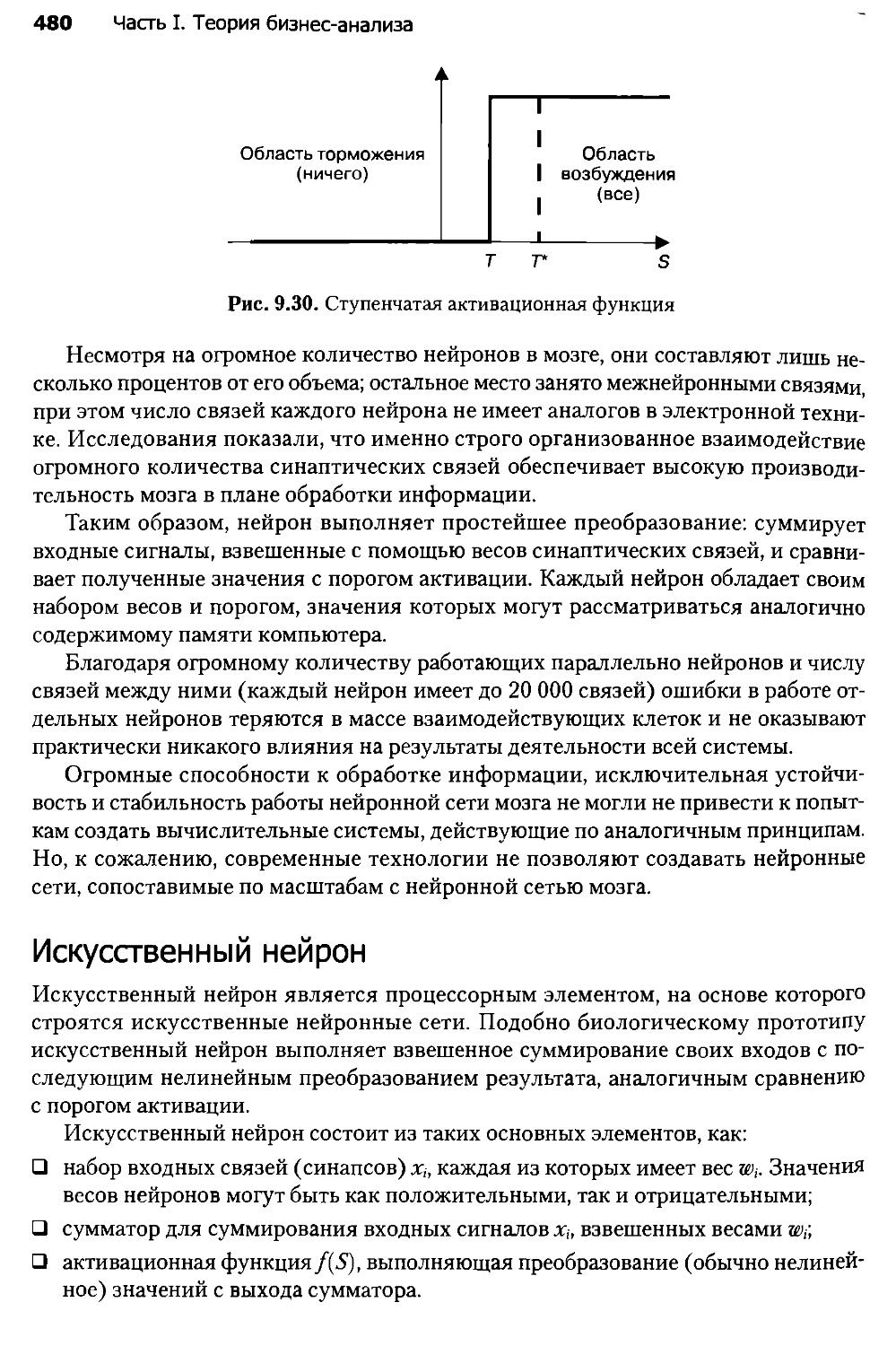

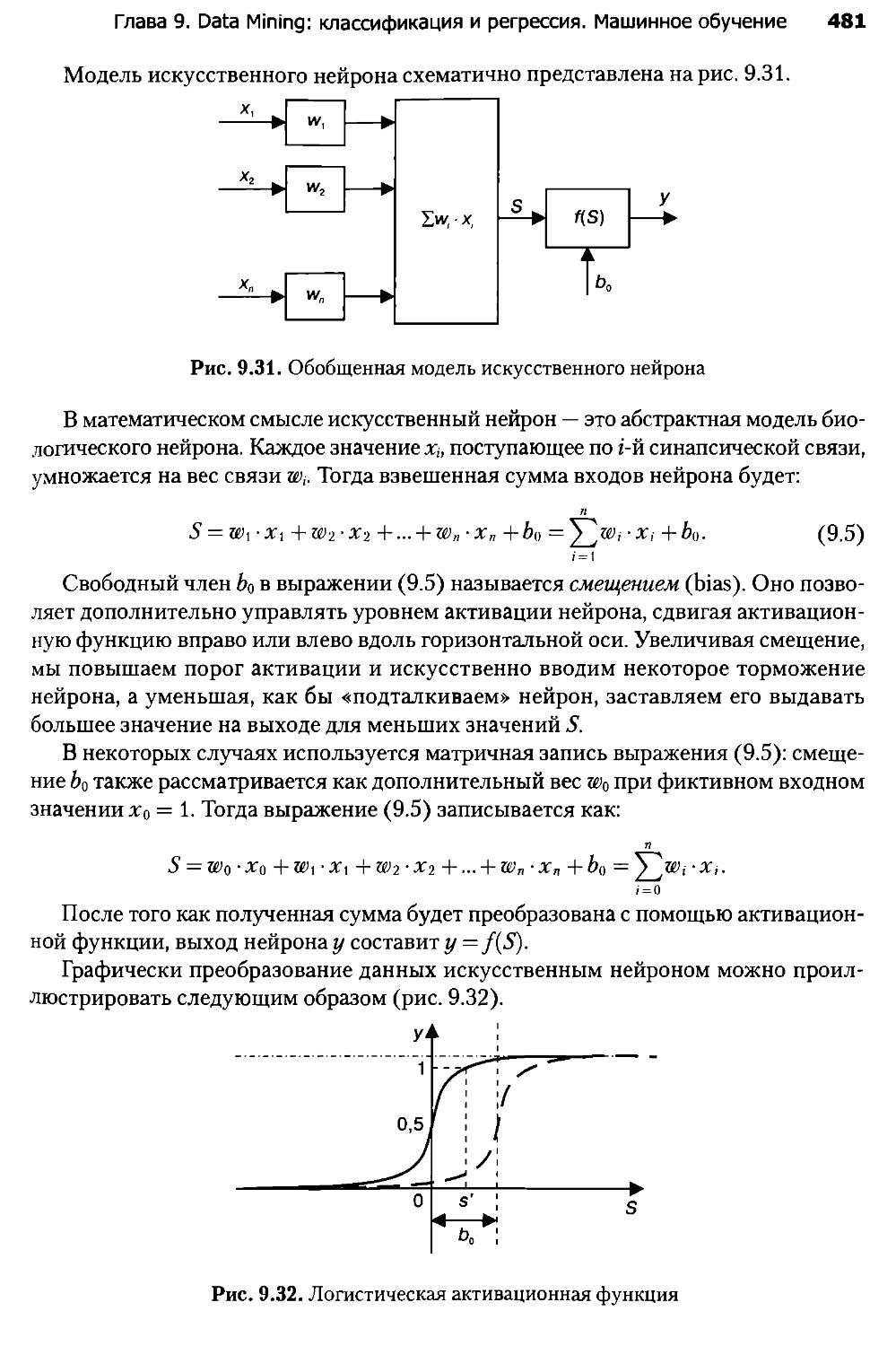

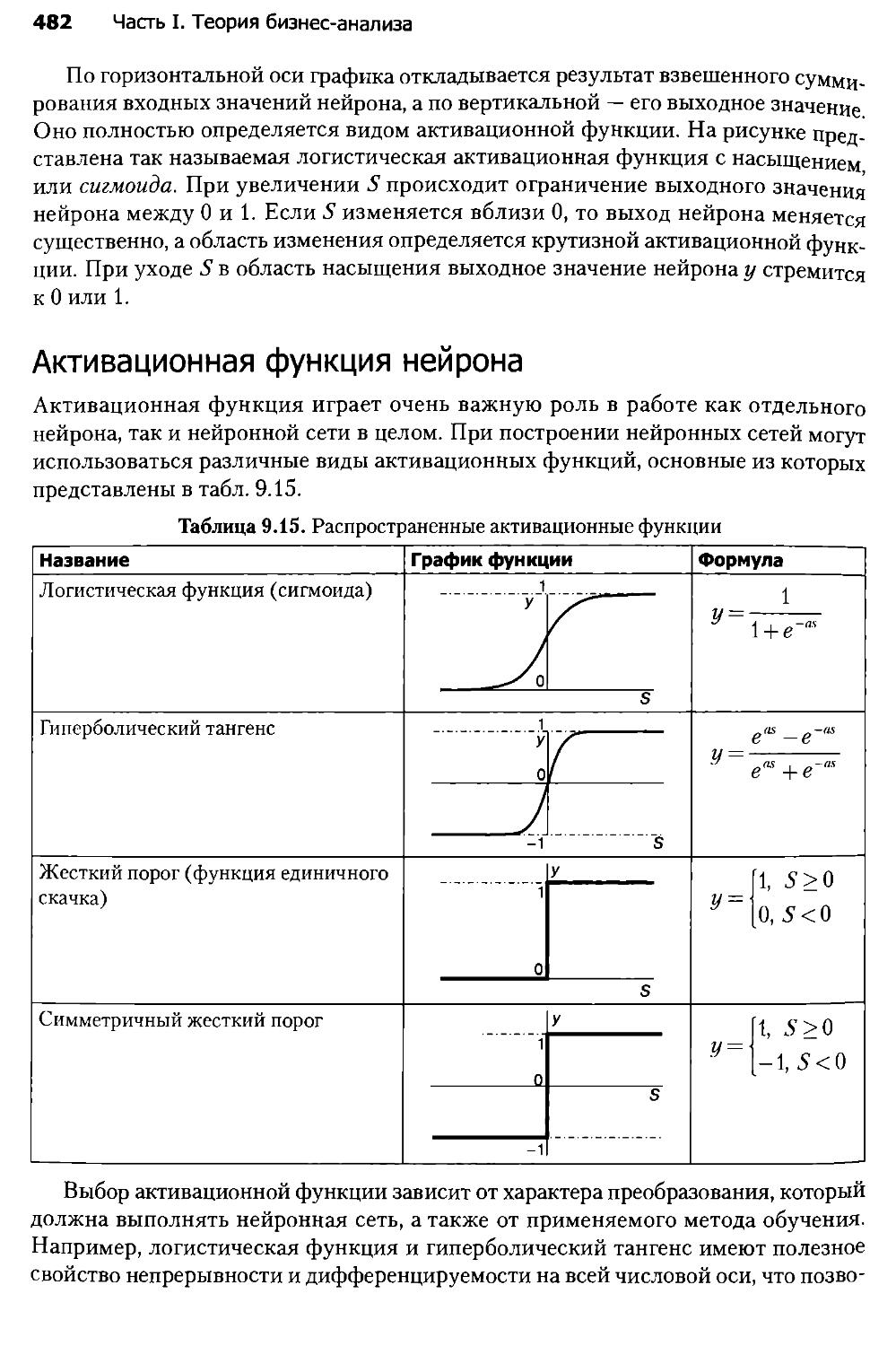

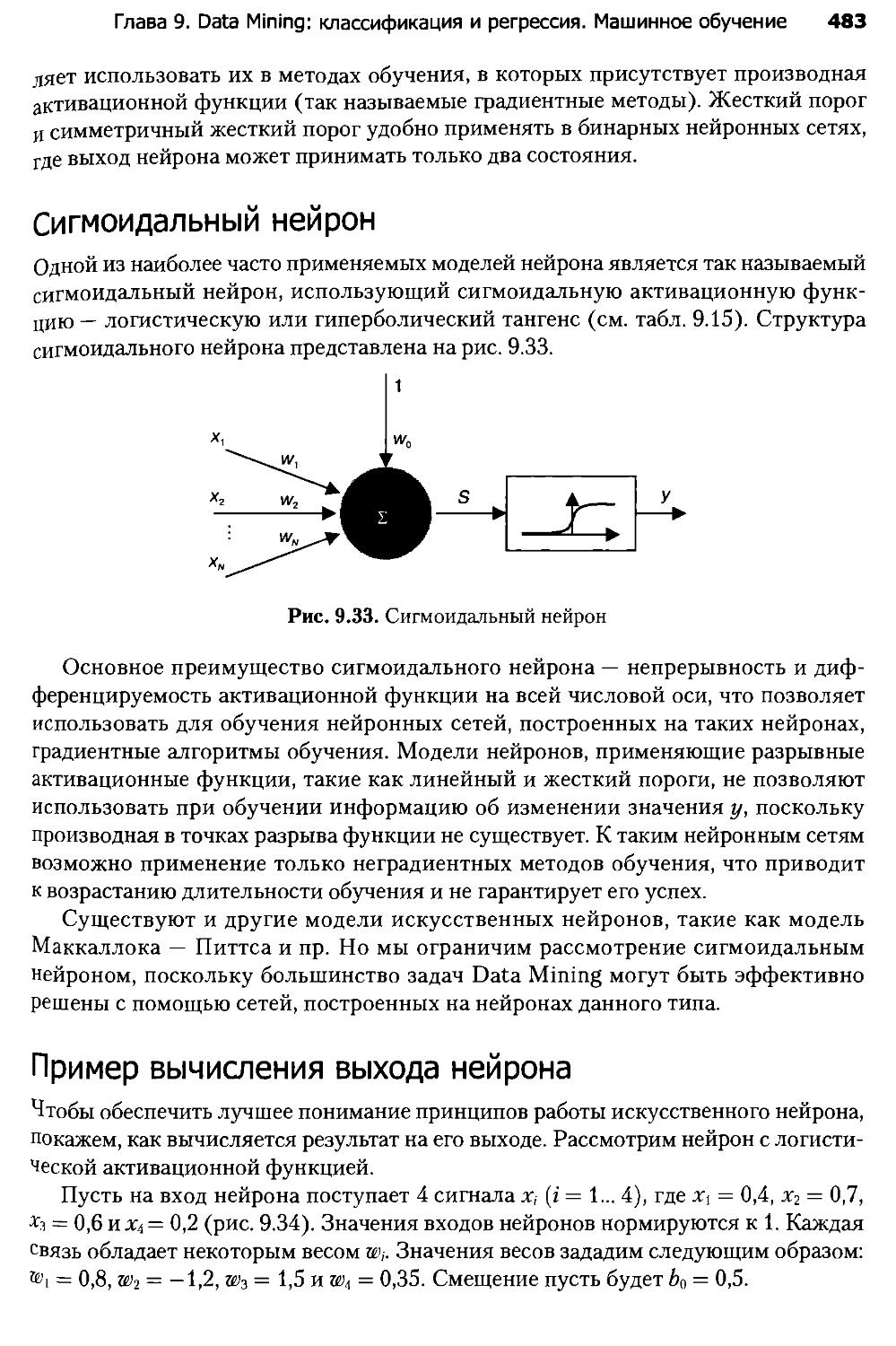

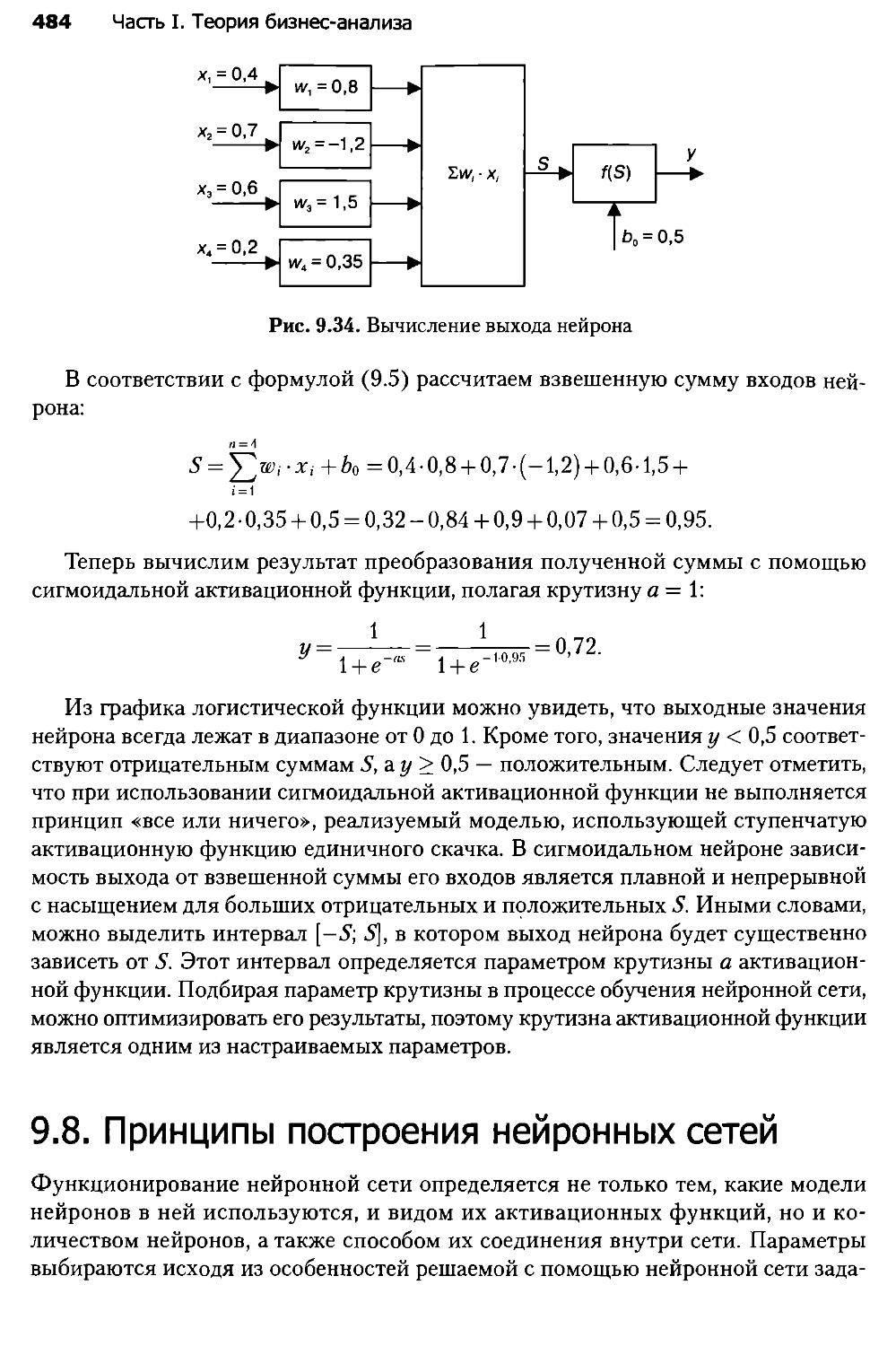

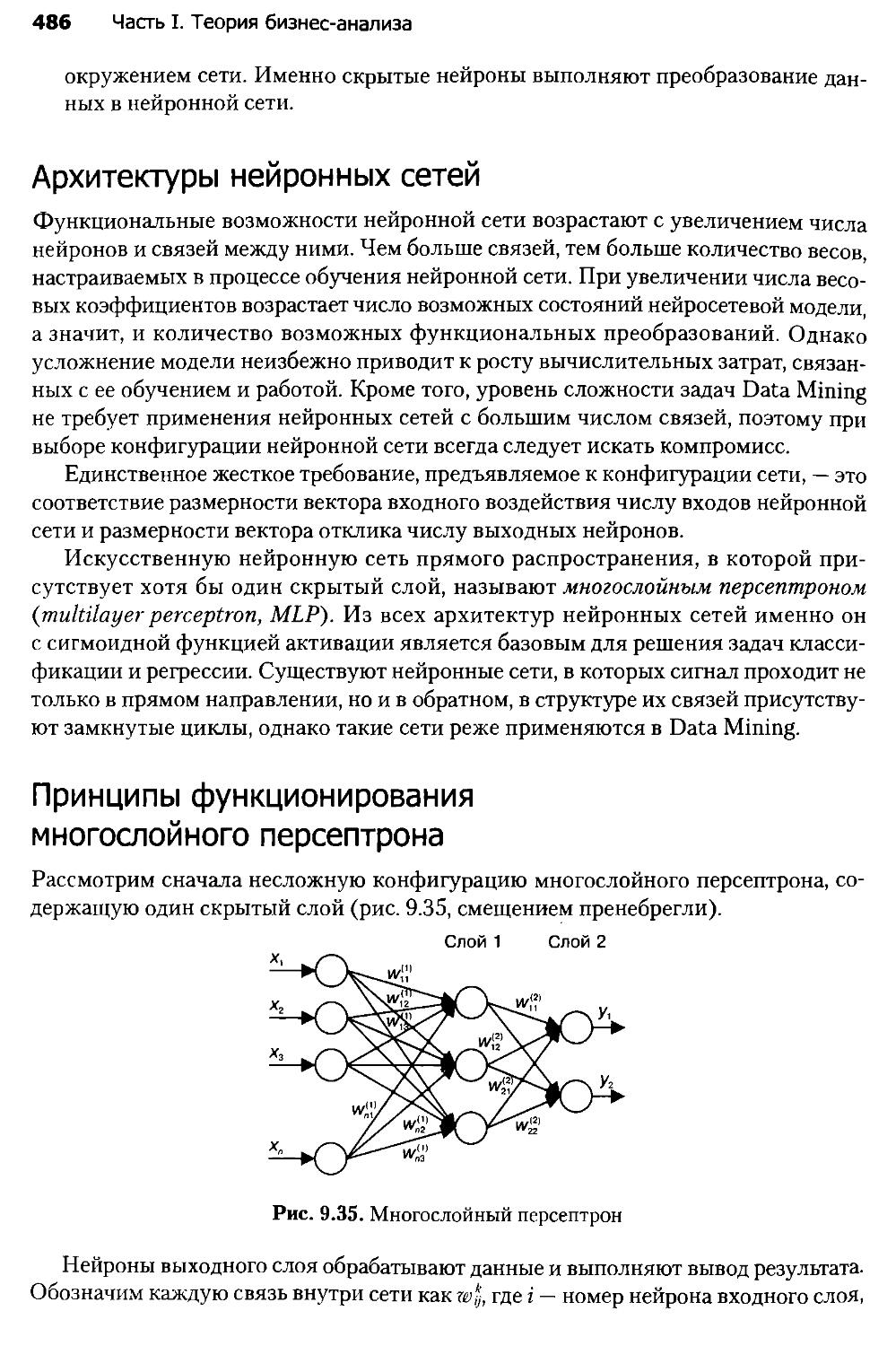

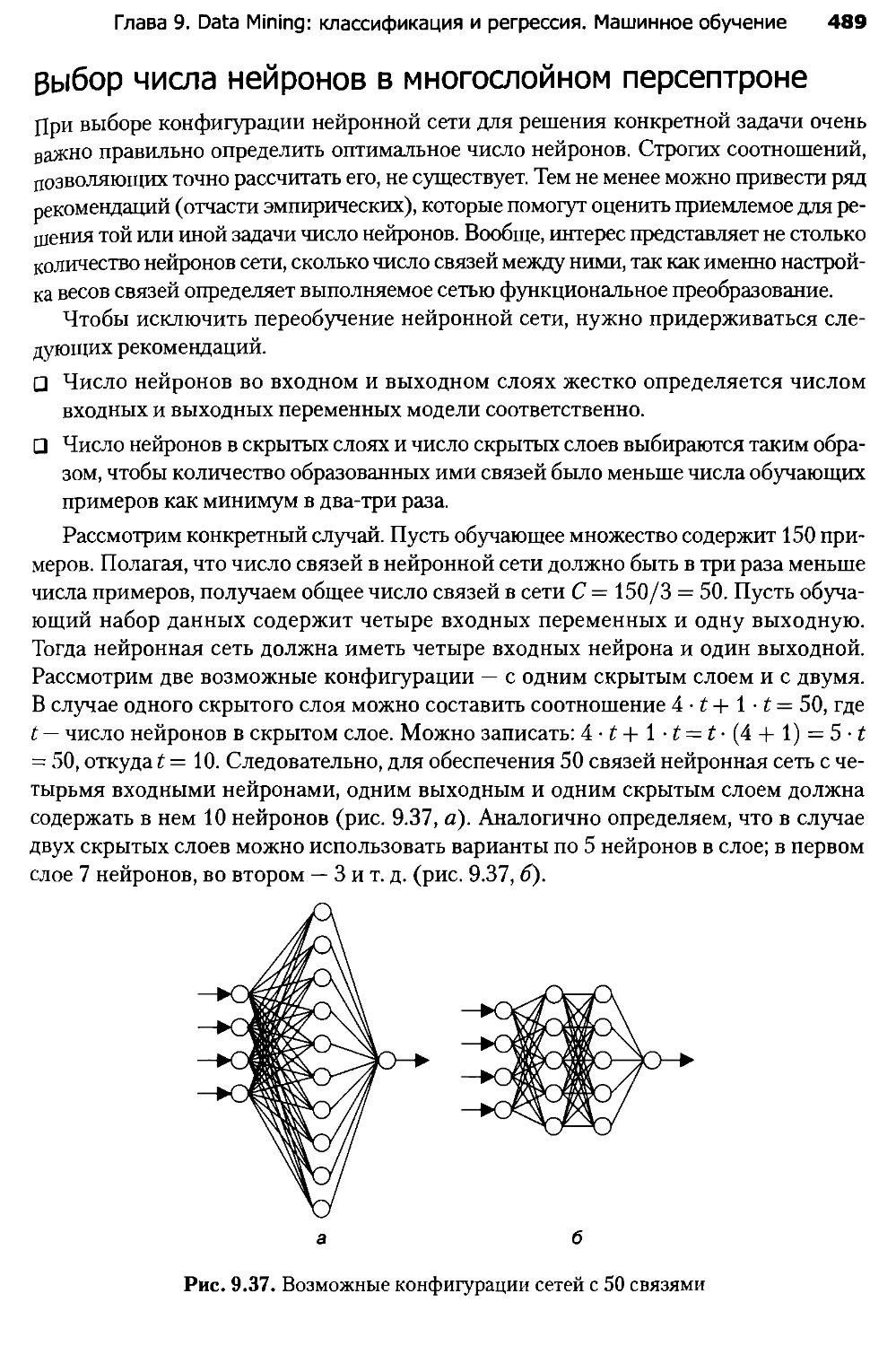

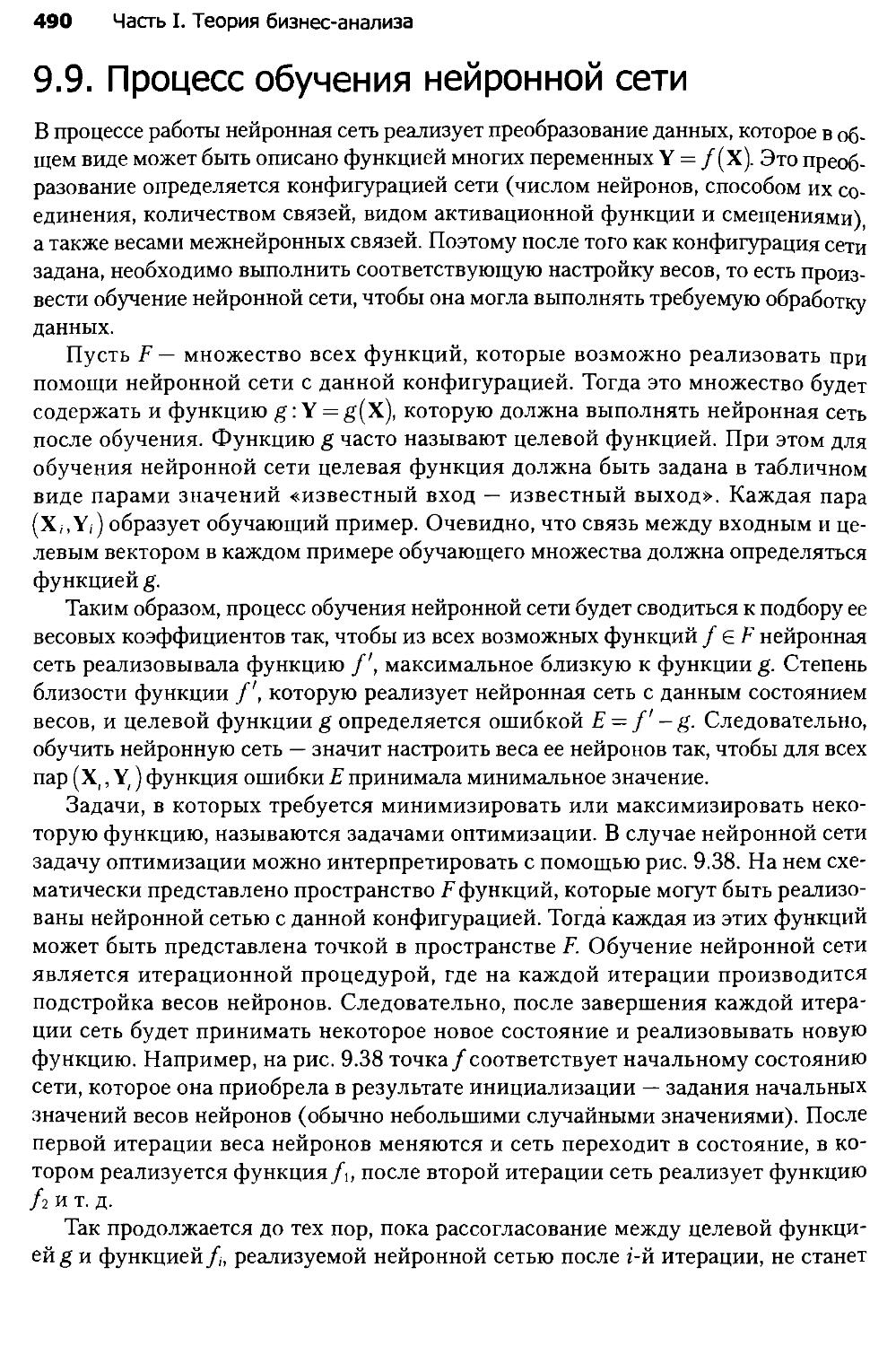

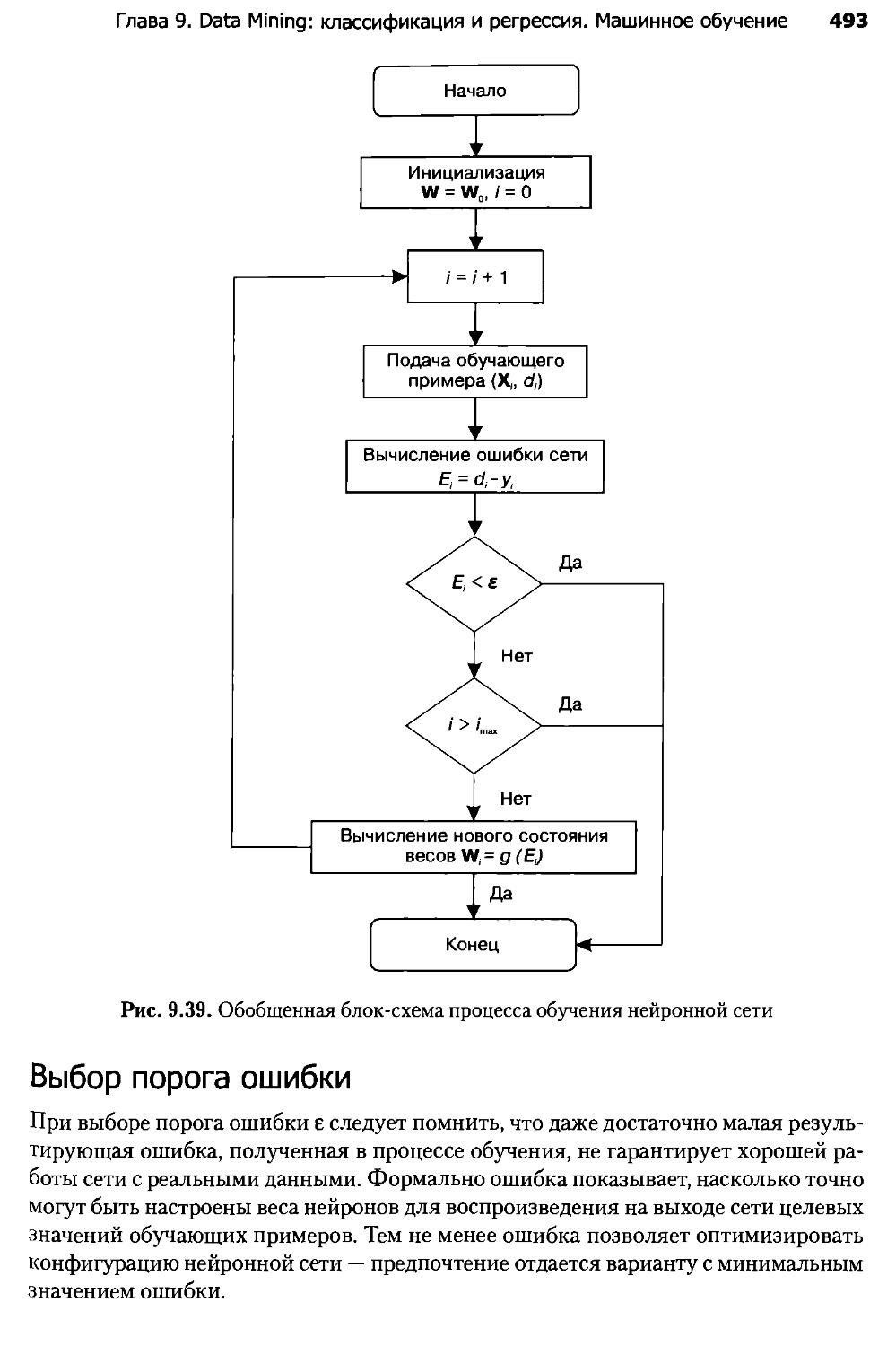

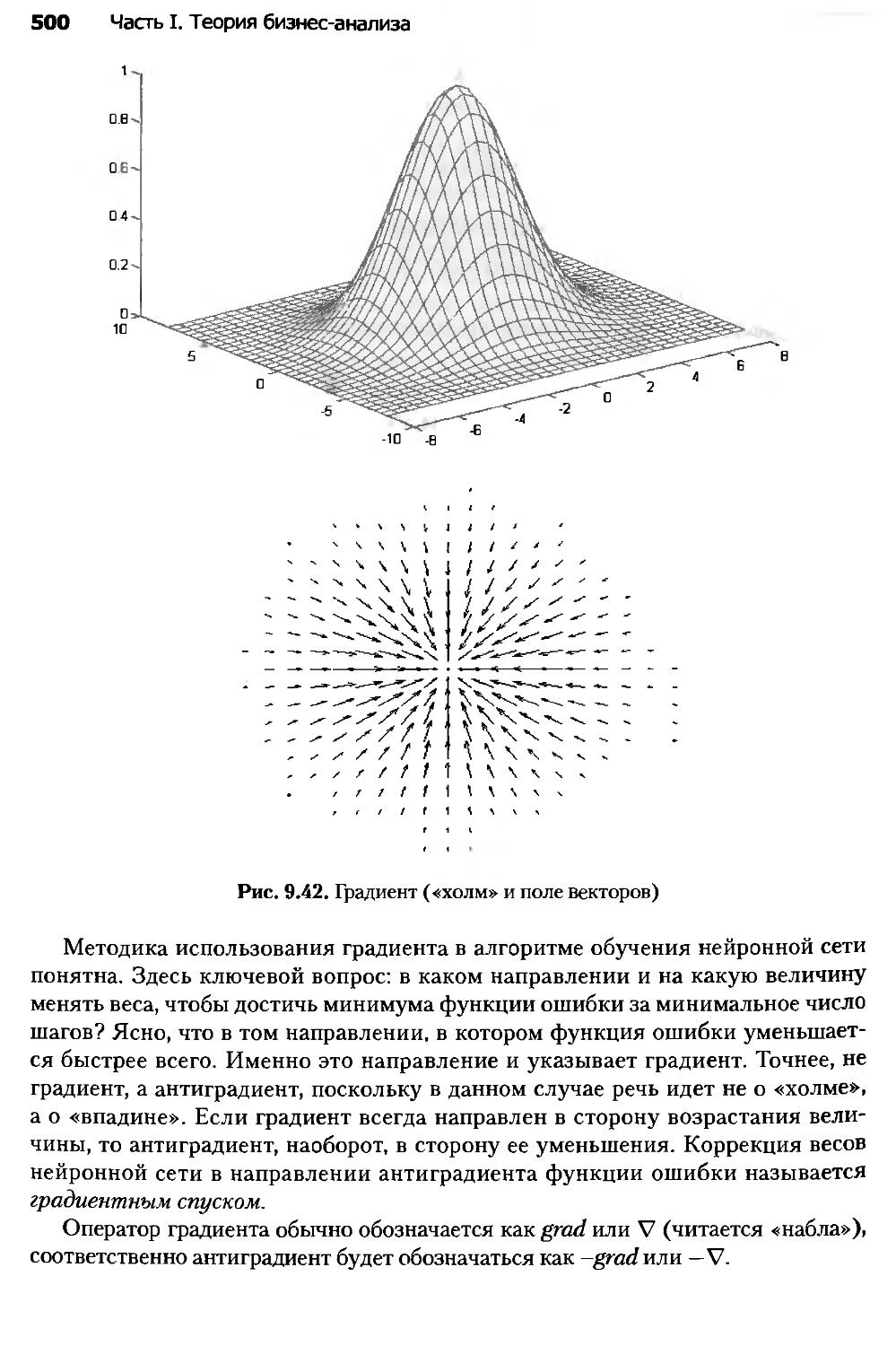

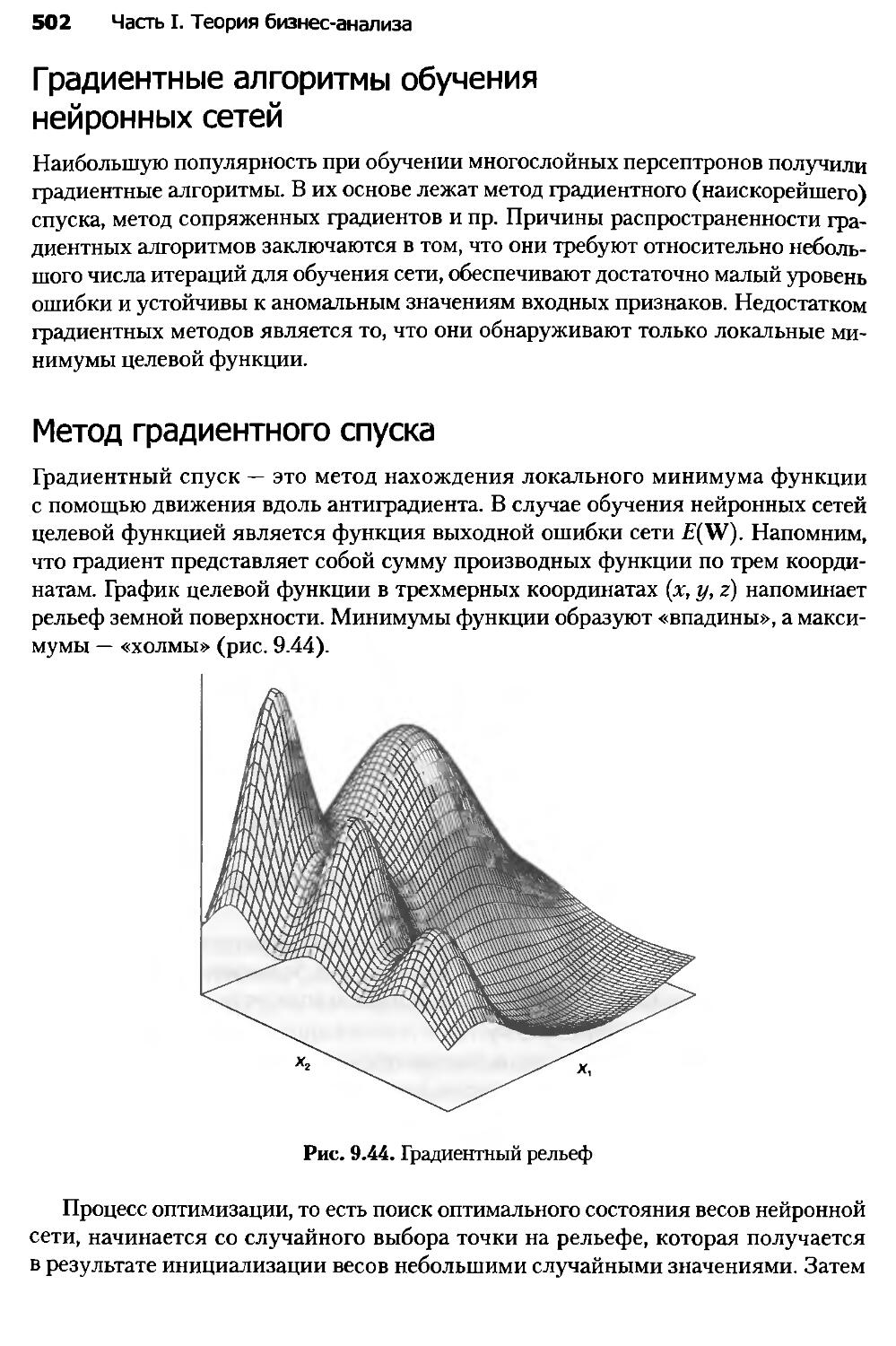

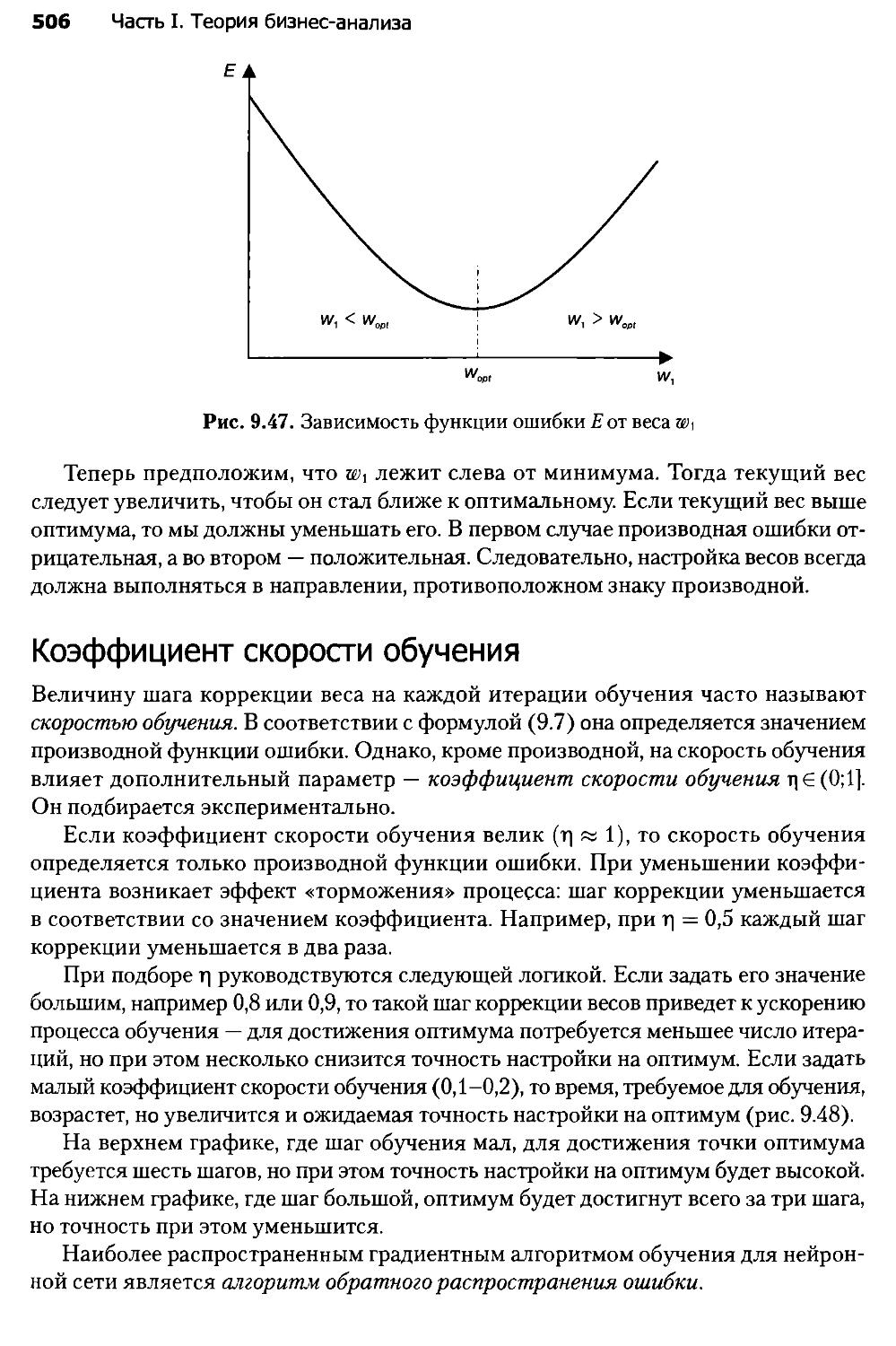

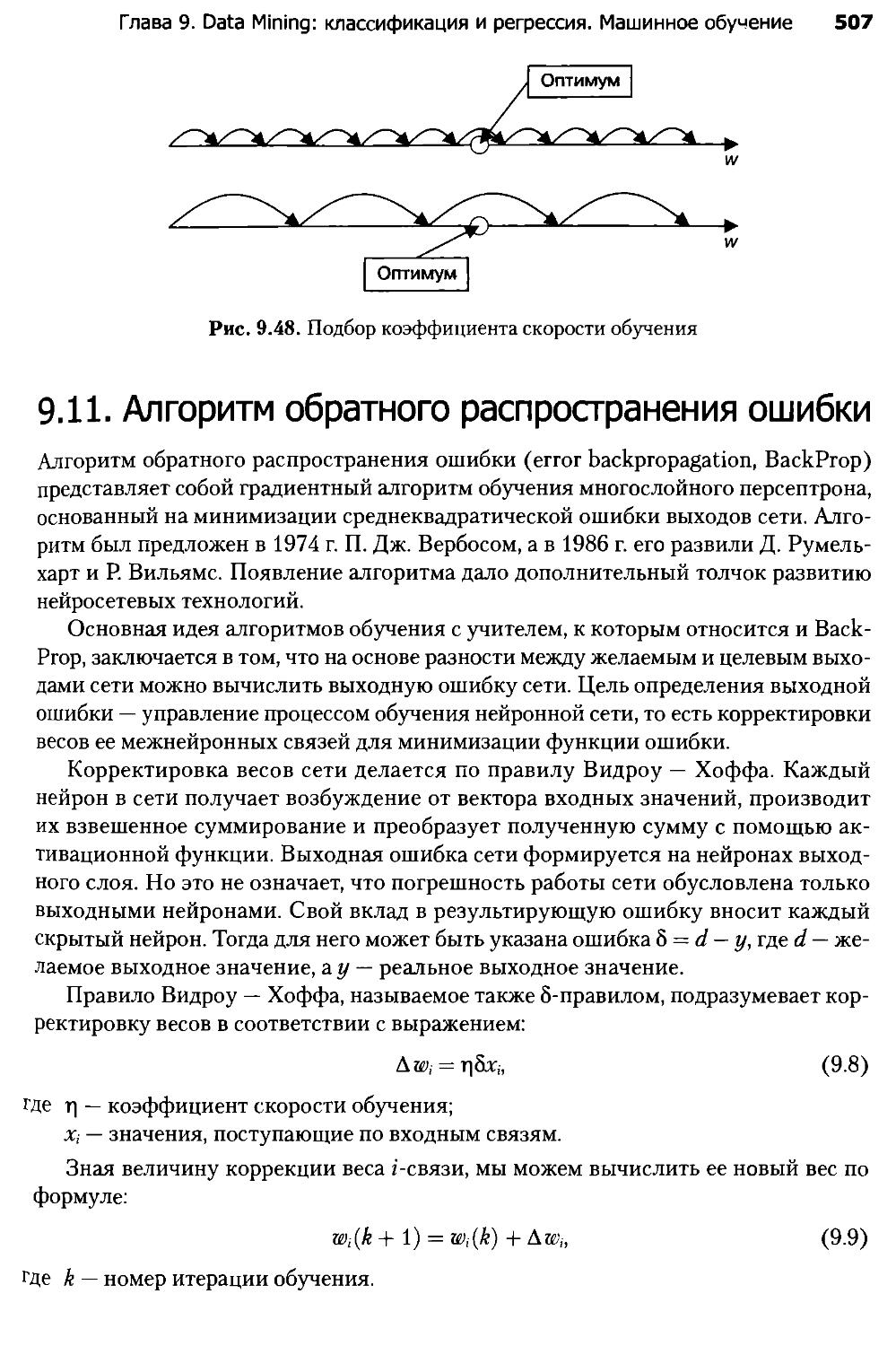

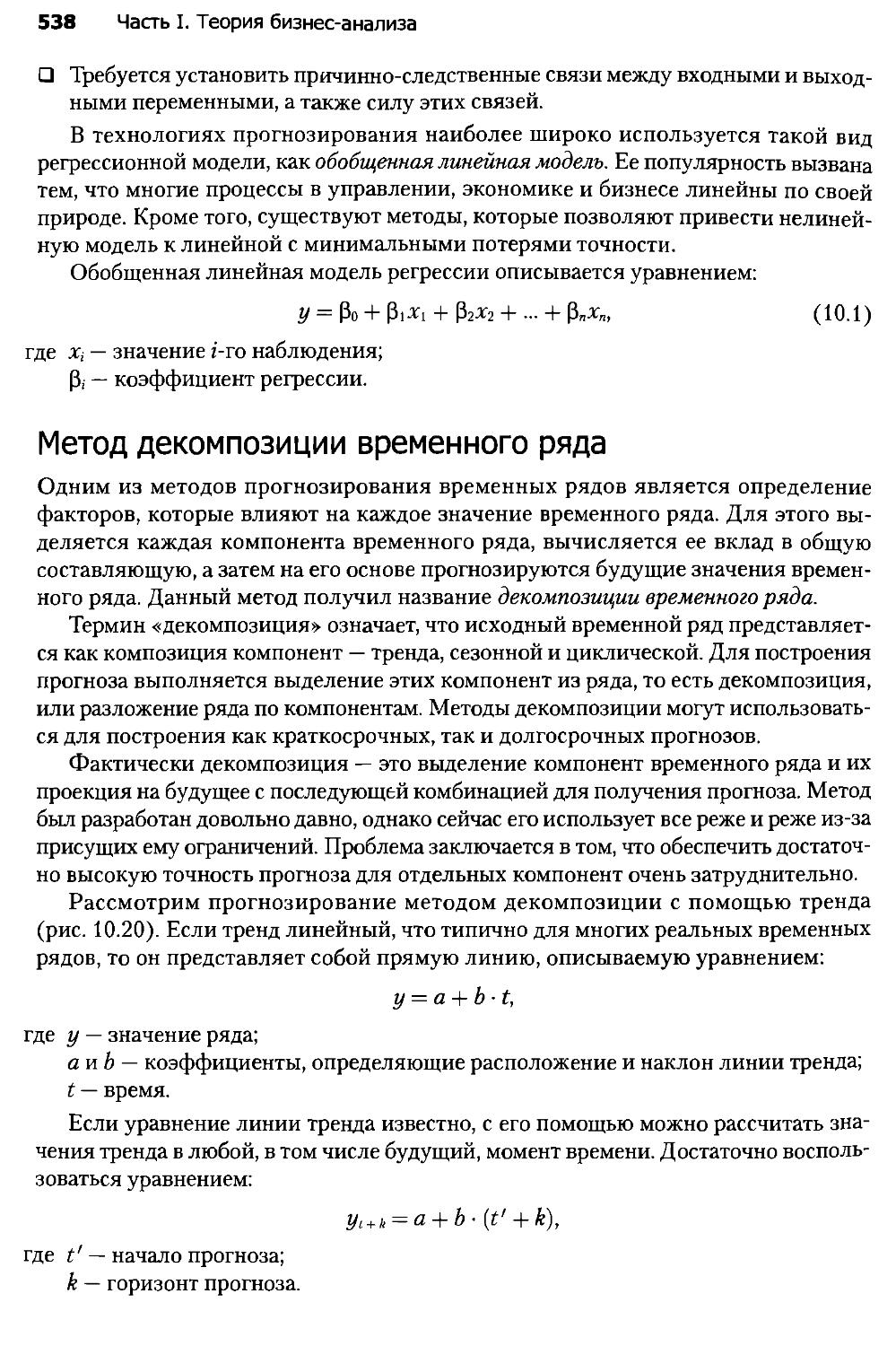

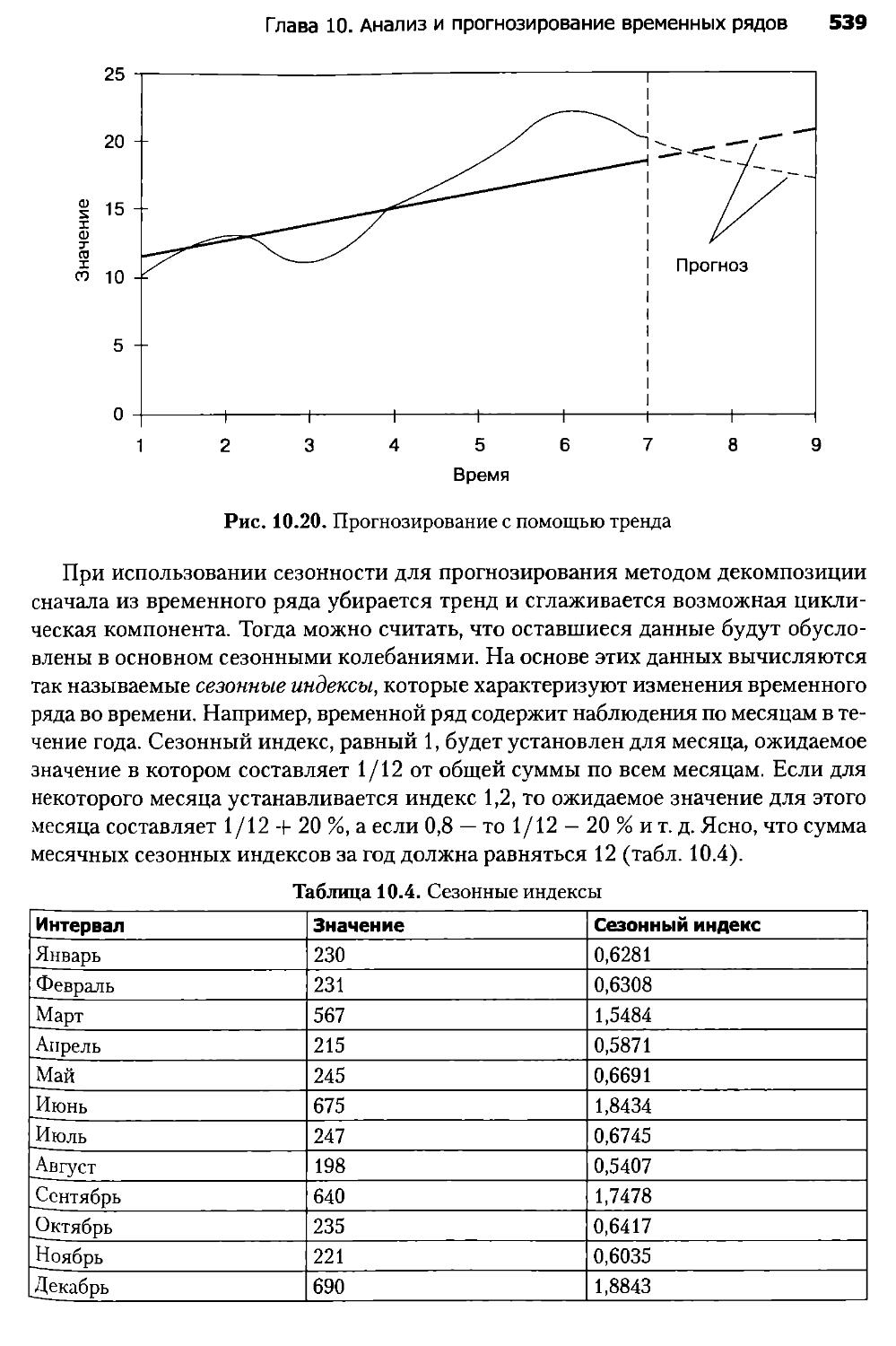

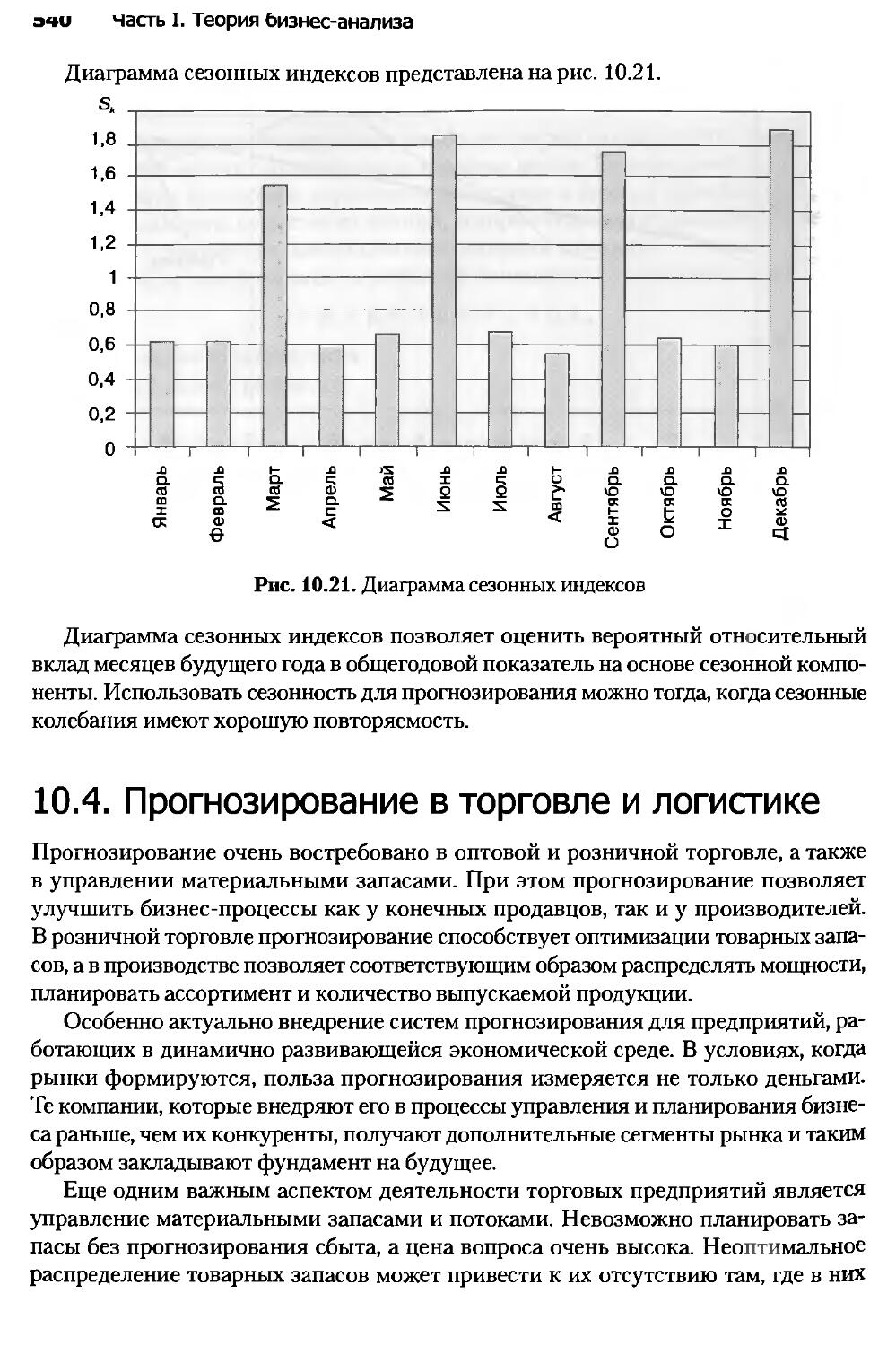

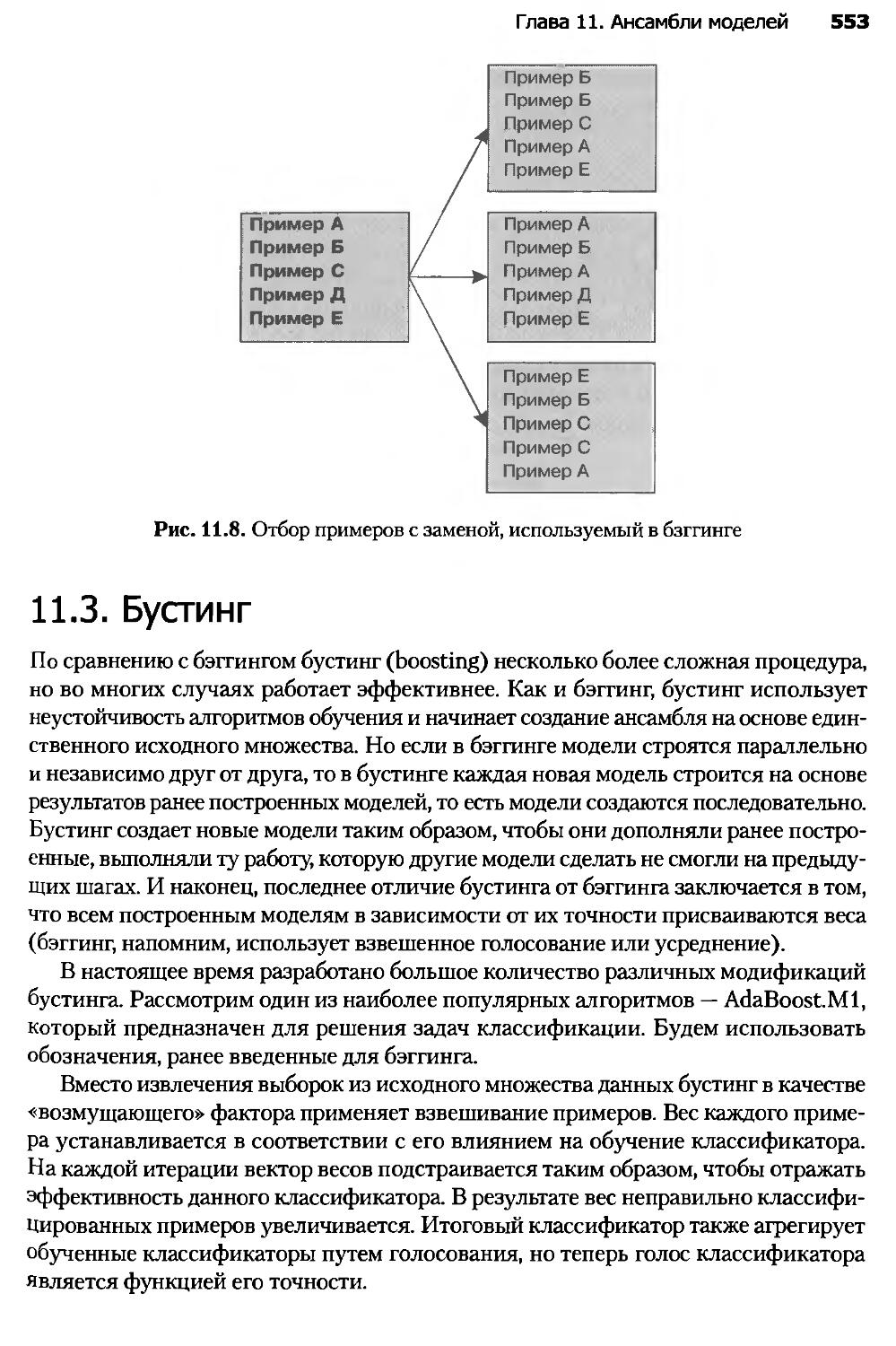

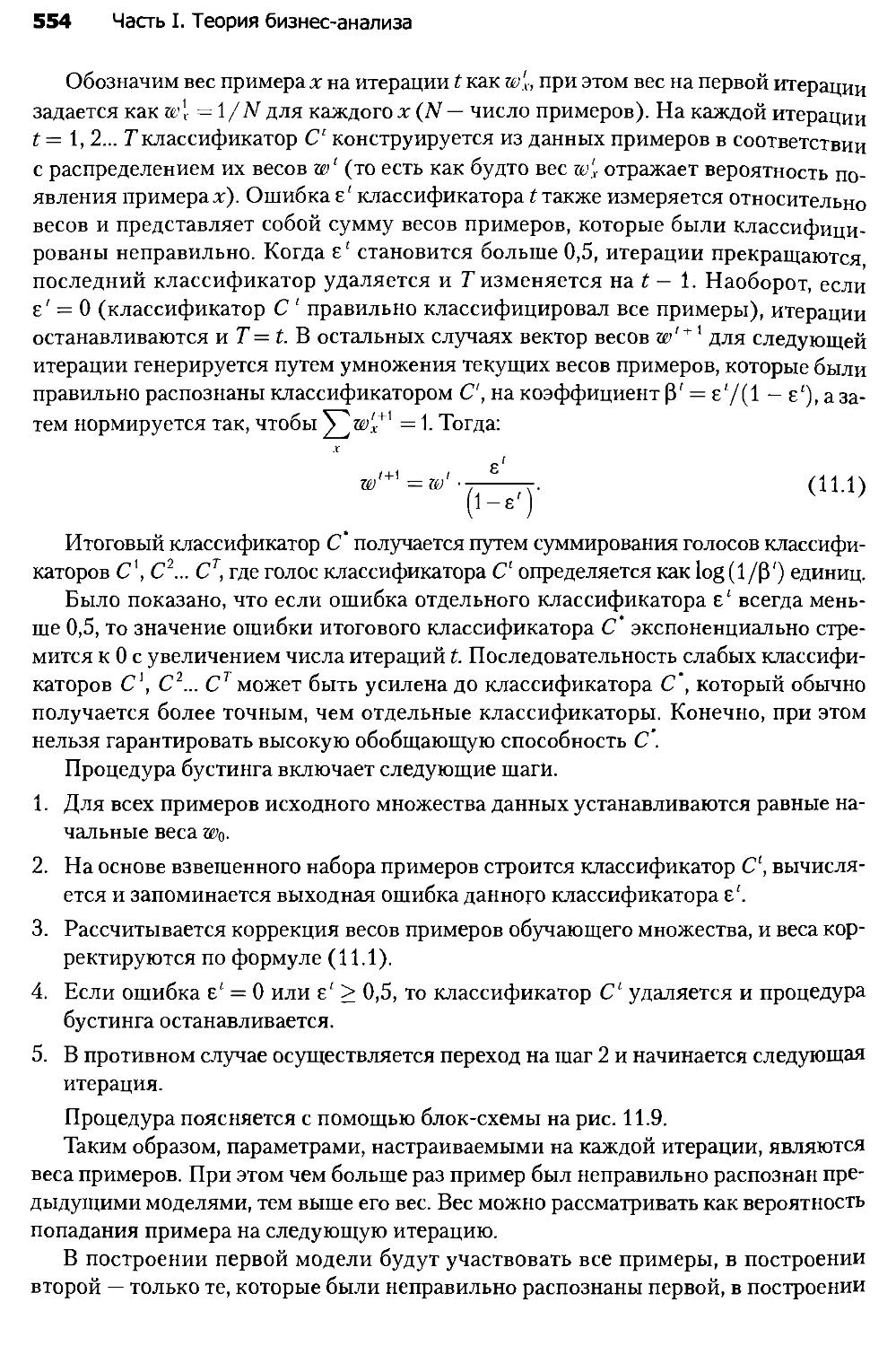

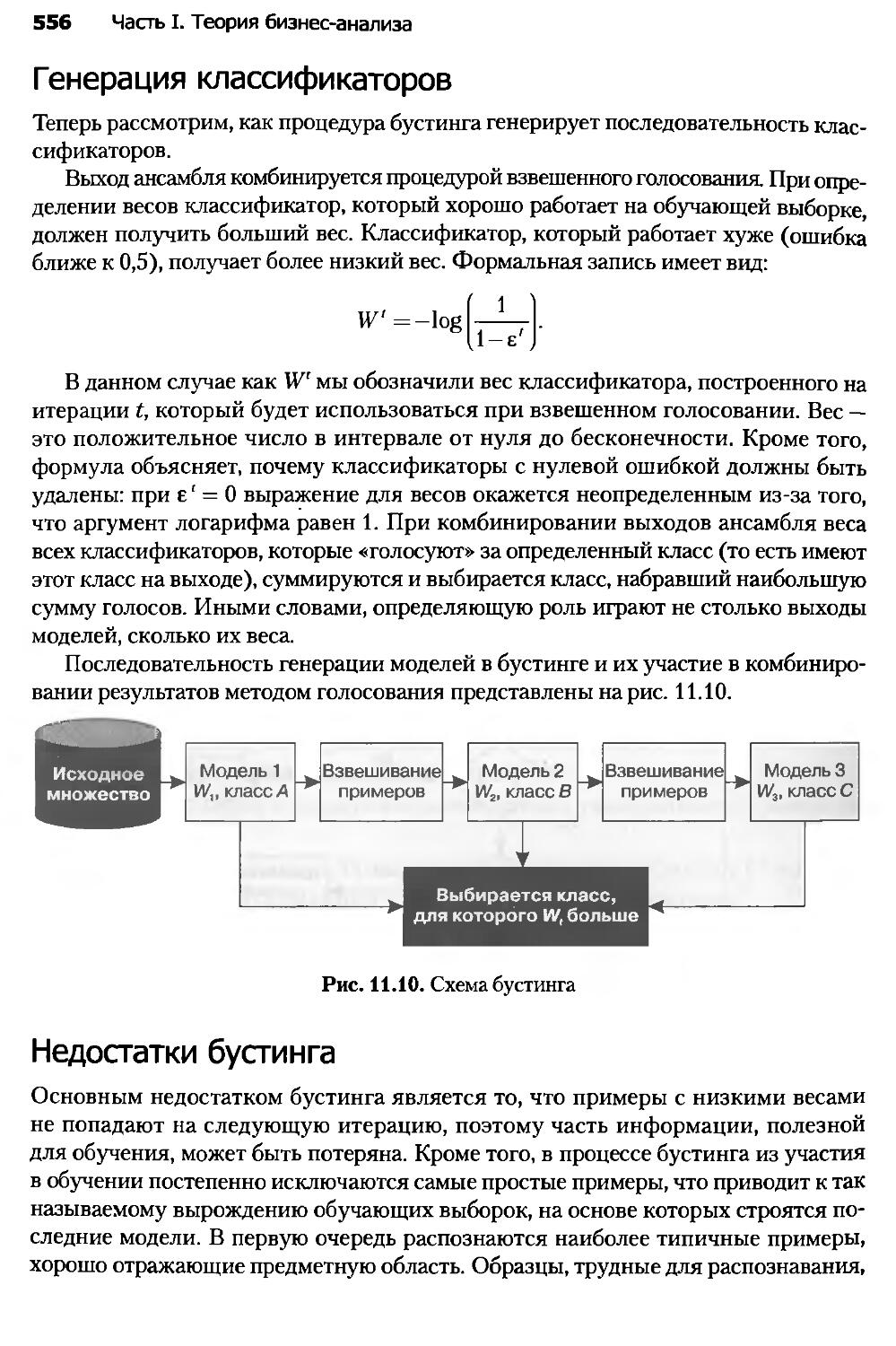

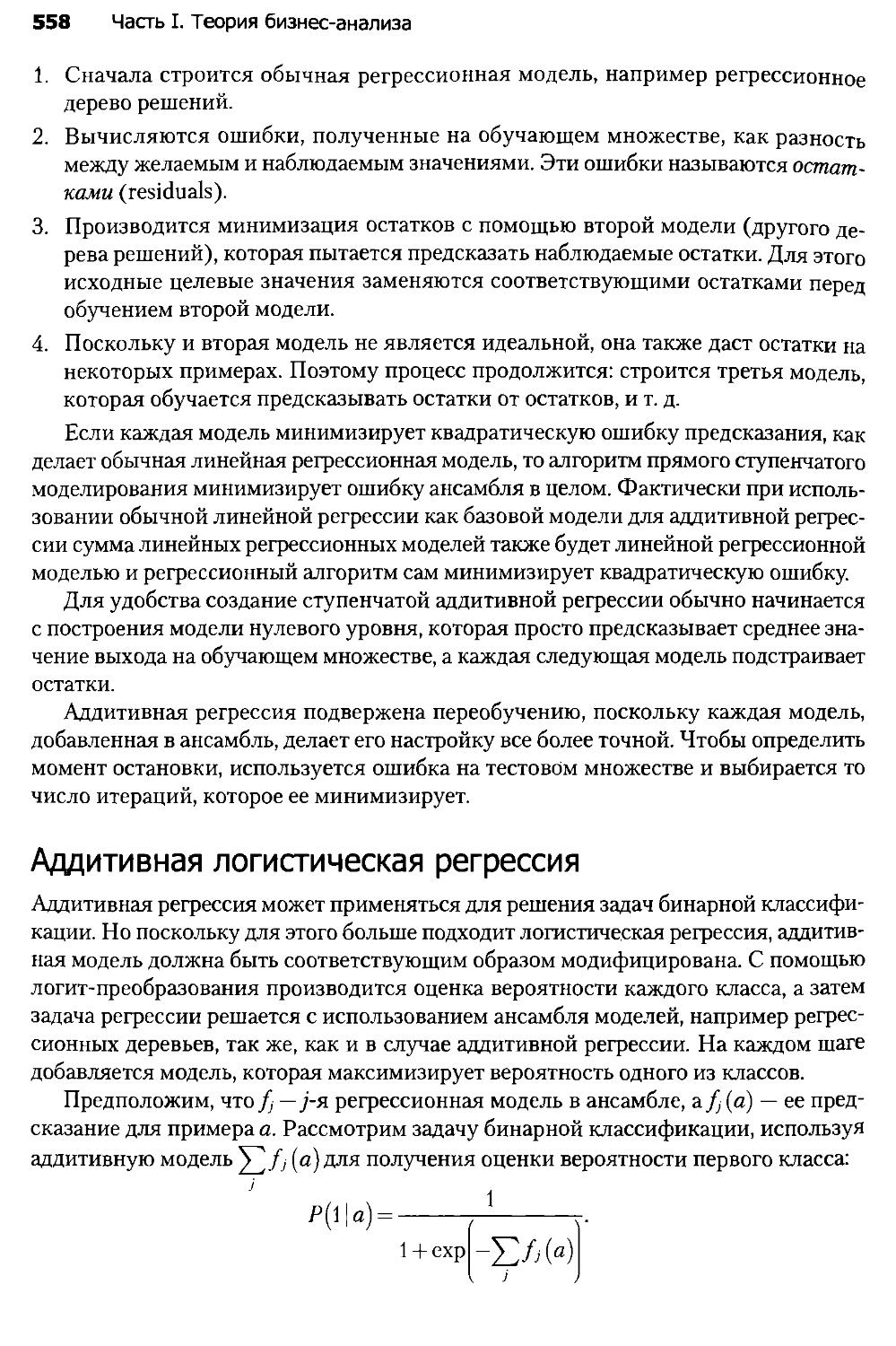

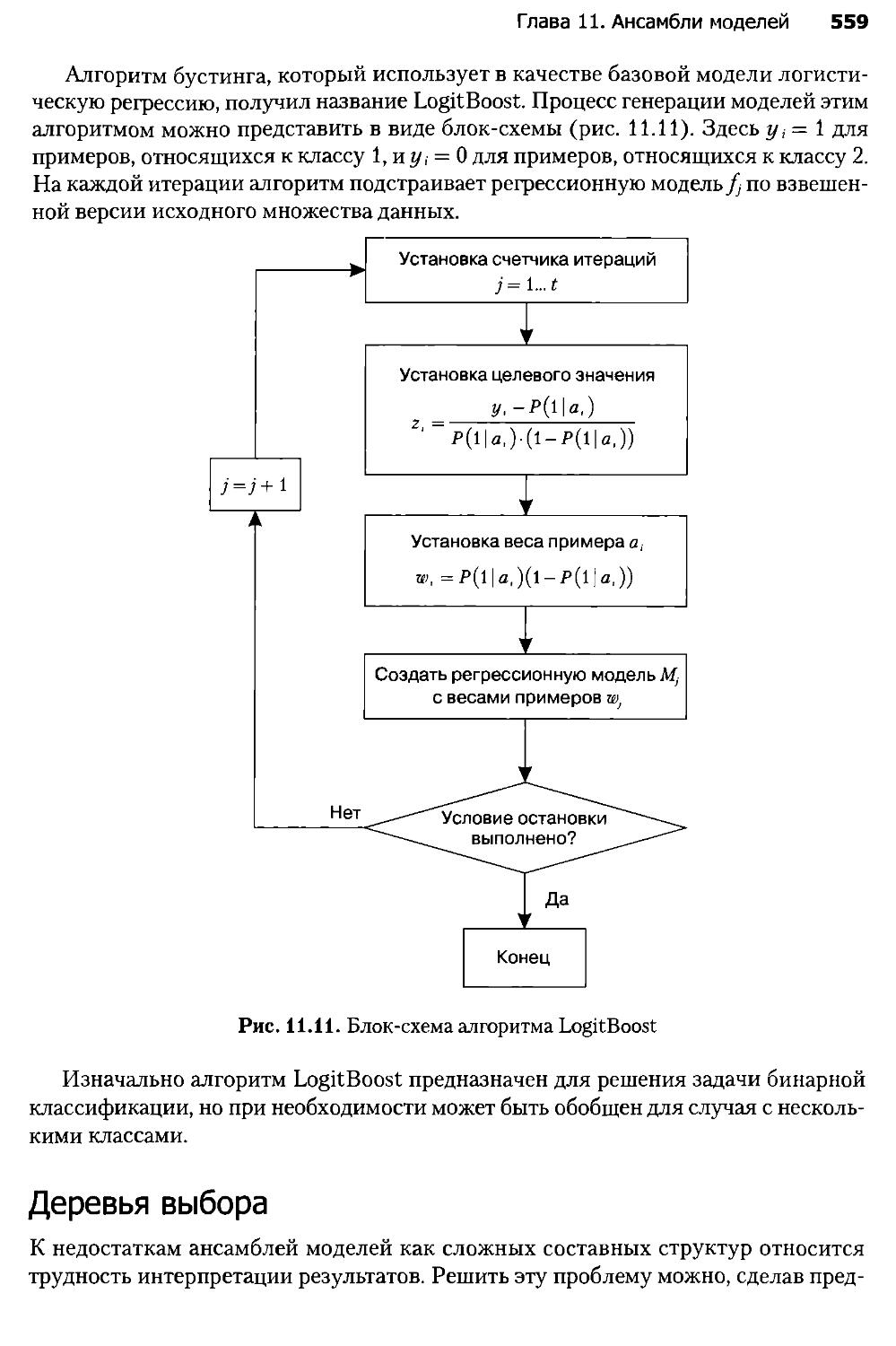

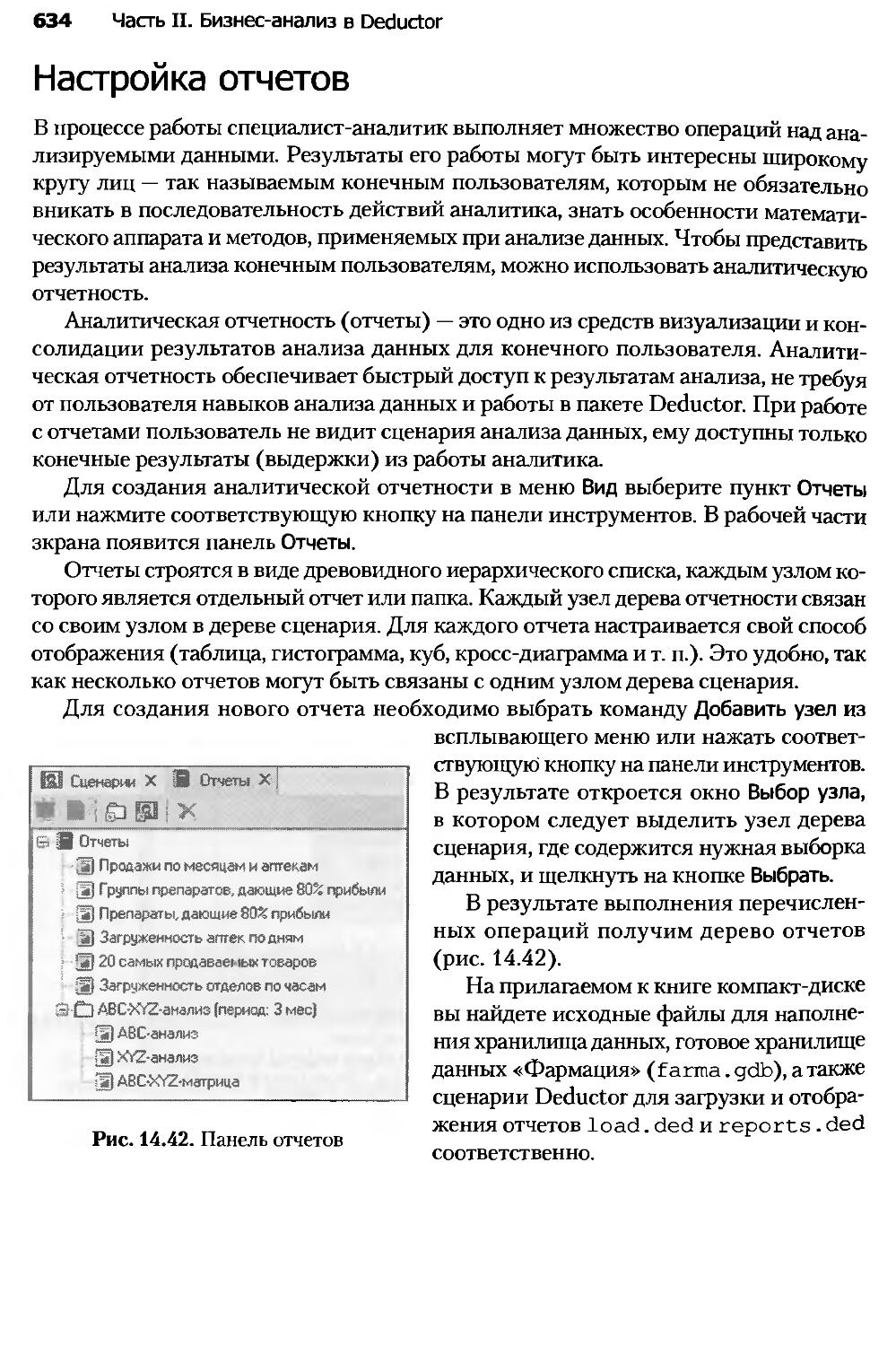

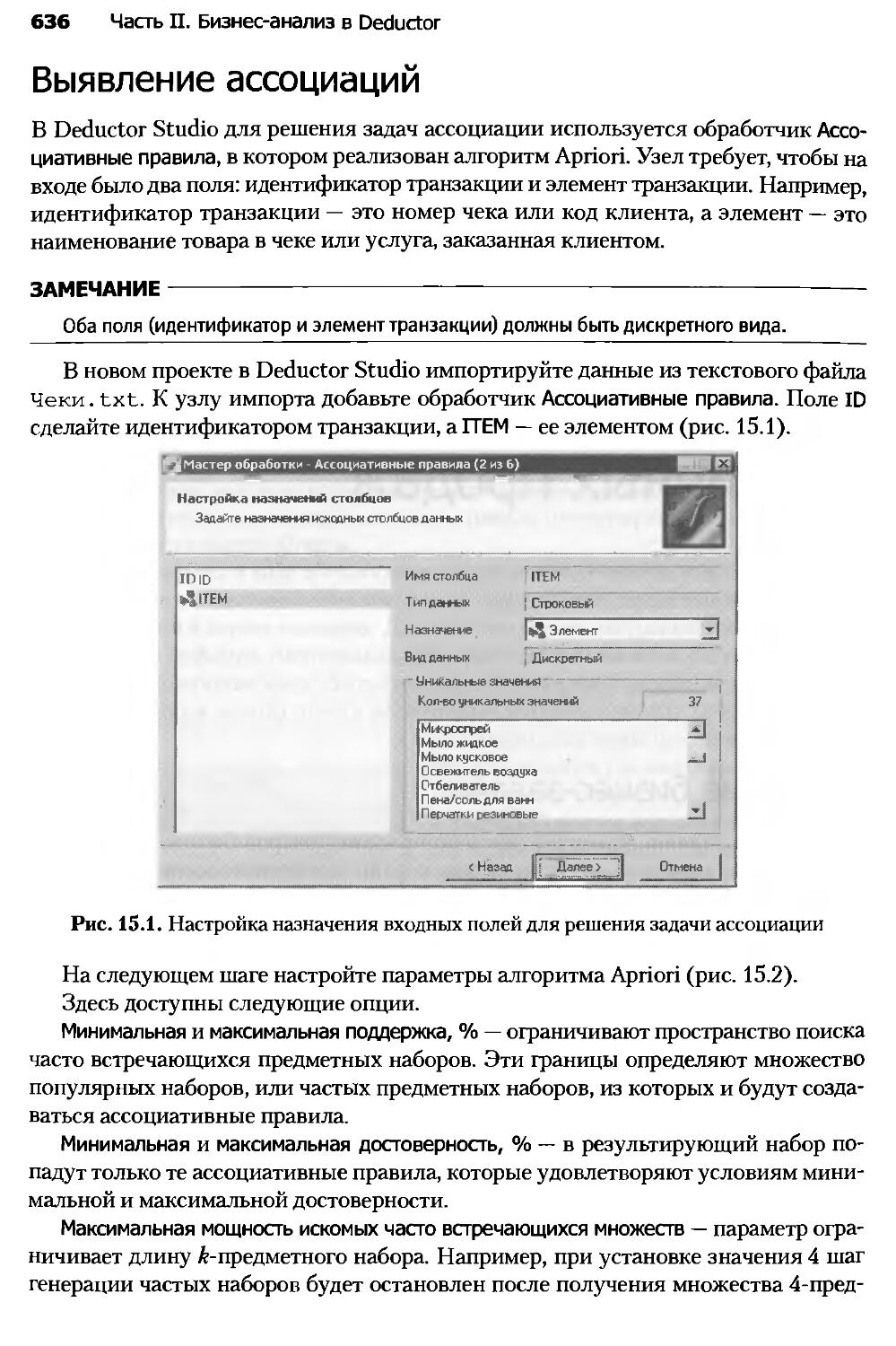

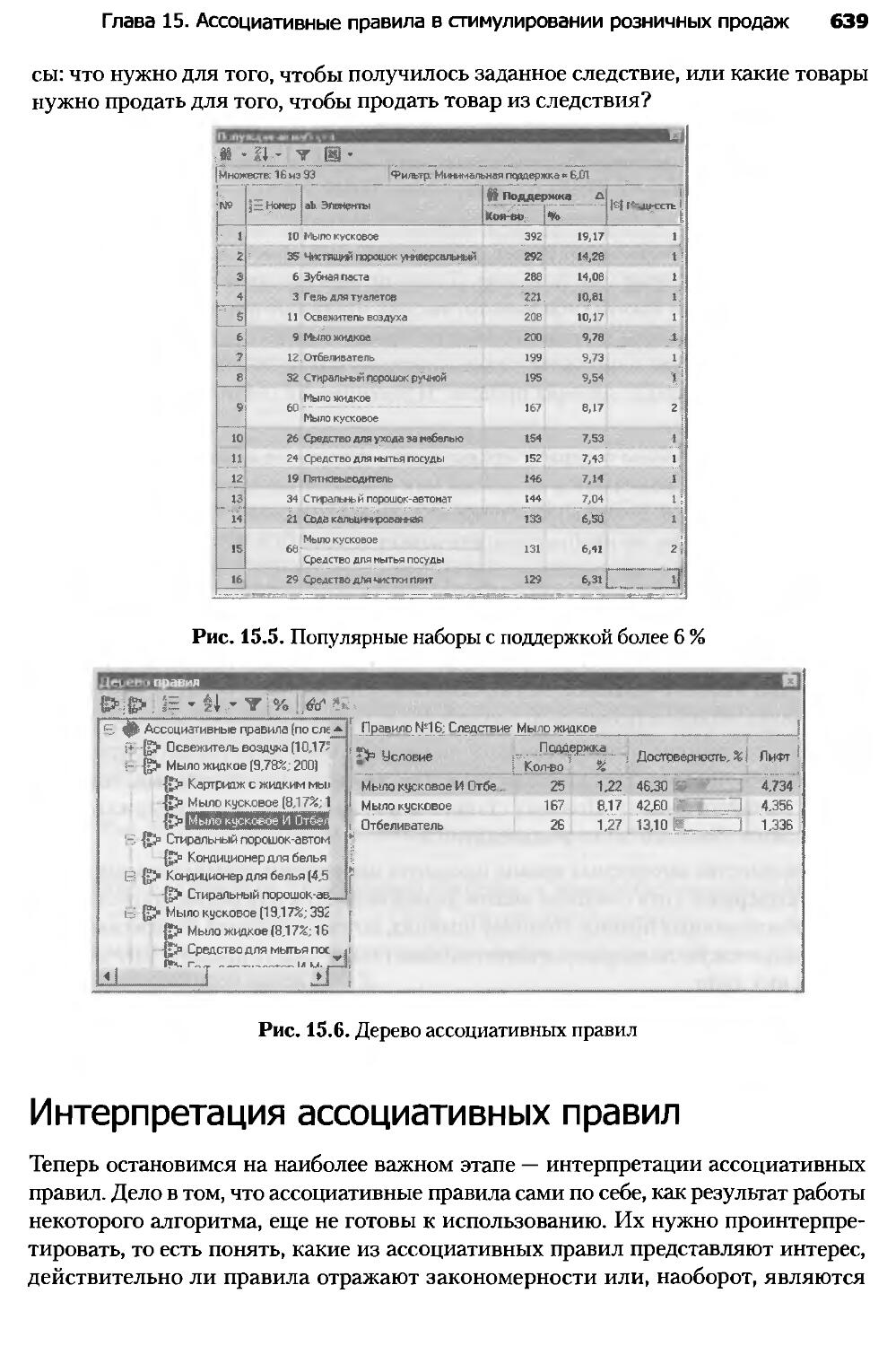

маются сбором данных и представлением результатов клиентам для после-