Текст

СПРАВОЧНИК

ПО ПРИКЛАДНОМ

СТАТИСТИКЕ

<

HANDBOOK OF APPLICABLE MATHEMATICS

Chief Editor: Walter Ledermann

Volume VI: Statistics

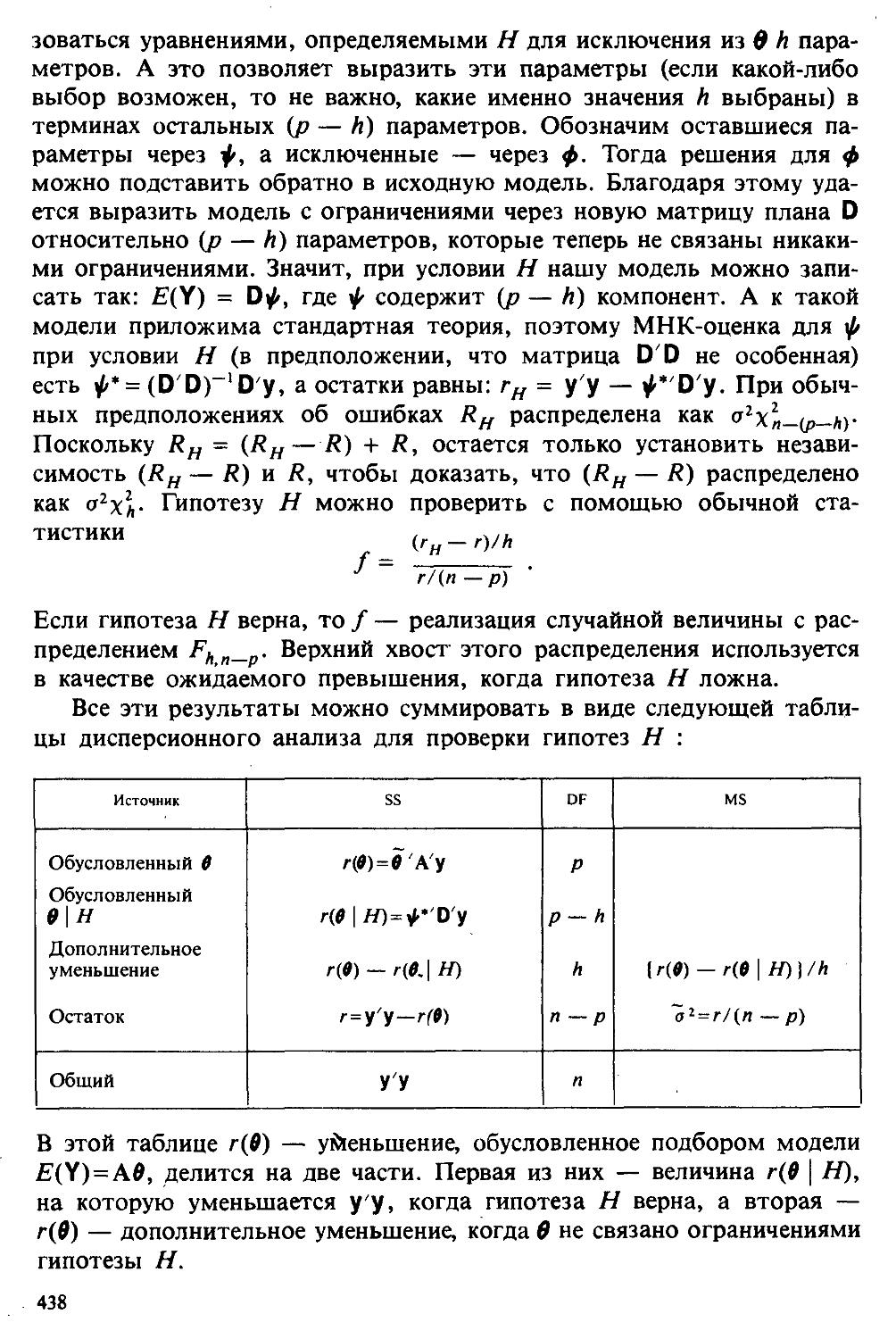

PART A

Edited by Emlyn Lloyd University of Lancaster

A Wiley-lntersclence Publication

JOHN WILEY & SONS

Ch ichester-New Yor k-Br isbane-Toronto-S i ng<

СПРАВОЧНИК ПО ПРИКЛАДНОЙ СТАТИСТИКЕ

Под редакцией Э. Ллойда, У. Ледермана

ТОМ 1

Перевод с английского под редакцией Ю.Н. Тюрина

(©

МОСКВА "ФИНАНСЫ И СТАТИСТИКА" 1989

ББК 16.2.9

С74

Справочник по прикладной статистике. В 2-х т. Т. 1: Пер. с С74 англ. / Под ред. Э. Ллойда, У. Ледермана, Ю. Н. Тюрина. —М.: Финансы и статистика, 1989.— 510 с.: ил.

ISBN 5-279-00245-3.

В Справочнике освещены основные математико-статистические методы.

Том 1 включает введение в статистику, вопросы, связанные с выборочным распределением, точечным и интервальным оцениванием, общую теорию статистических критериев, дисперсионный анализ, планирование эксперимента.

Для широкой аудитории специалистов, разрабатывающих и использующих статистические методы.

0702000000 —131

010(01)-89

109-89

ББК 16.2.9.

ISBN 5-279-00245-3 (Т. 1, рус.)

ISBN 5-279-00244-5

ISBN 0-471-90274-8 (англ.)

©1984 by John Wiley & Sons Ltd.

© Перевод на русский язык, предисловие, «Финансы и статистика», 1989

ПРЕДИСЛОВИЕ К РУССКОМУ ИЗДАНИЮ

Математизация знания, получившая техническую базу в виде широкого распространения все более совершенных ЭВМ, привела к тому, что математико-статистические методы вошли в жизнь почти каждого специалиста. В связи с этим возникла массовая потребность быстро получать необходимые оценки и расчеты, не углубляясь в вычислительные детали и математические доказательства.

Ведущие издательства мира выпускают в помощь специалистам, имеющим дело с математическим аппаратом, многотомные энциклопедии и различного рода справочники. Каждое такое издание имеет определенные особенности и свой круг читателей. Некоторые издания предназначены в первую очередь для математиков и для использования содержащегося в них материала «внутри математики». Такова, например, вышедшая в нашей стране «Математическая энциклопедия». Другие предназначены для математиков-консультантов, к которым обращаются специалисты других отраслей знания (профессия, лишь недавно ставшая распространенной). Третьи адресованы тем, кто, не считая себя математиком, применяет или хотел бы применять математические методы в своей работе.

В справочной литературе такого рода большое внимание уделяется математической статистике. Количество посвященных ей изданий довольно значительно. Отметим из них лишь 14-томный справочник по статистике «Handbook of Statistics» (Amsterdam: North Holland), шесть томов которого уже вышли в свет, и 9-томную энциклопедию статистических наук «Encyclopedia of Statistical Sciences» (New York: Wiley).

К сожалению, на русском языке аналогичных изданий пока нет. Этот пробел отчасти восполнят готовящаяся издательством «Советская энциклопедия» многотомная энциклопедия по теории вероятностей и математической статистике, а также предлагаемый читателю «Справочник по прикладной статистике» под редакцией Э. Ллойда и У. Ледермана. Он предназначен для широкого круга читателей. Это перевод одного из шести томов, вышедших в серии «Handbook of Applicable Mathematics» издательства Wiley. В состав серии входят также тома, посвященные алгебре (I), теории вероятностей (II), численным методам (III), математическому анализу (IV), геометрии и комбинаторике (V). Справочник по прикладной статистике представляет собой шестой том серии. В русском переводе, как и в оригинале, он выходит в двух томах.

Слово «Applicable» в названии серии употребляется вместо традиционного «Applied», что довольно непривычно. Оно подчеркивает, что речь идет о математике, имеющей приложения за ее пределами. Необычность названия указывает на сугубо практическую направленность излагаемого материала.

В наших программах обучения математике уделяется явно недостаточное внимание статистическому подходу к явлениям природы и общества. Давно назрела необходимость пересмотра этих программ. Владение основами математической статистики нужно каждому экономисту, социологу, инженеру и естествоиспытателю. Функциональные связи, которыми оперируют математики, иногда не проявляются в «чистом виде». Они всегда осложнены случайными погрешностями и обстоятельствами, роль которых нельзя адекватно учесть вне статистического мышления и без соответствующего аппарата. Для студентов же, которые по роду своей профессии будут иметь дело с массовыми явлениями, необходимы не столько математические, сколько математико-статистические знания. Будущие специалисты чаще всего не вспоминают об аналитической геометрии или правилах дифференцирования, но остро чувствуют недостаток статистических знаний. В подобных случаях настоящий Справочник будет служить им надежным руководством.

Среди отечественных работ по математической статистике нет изданий, предназначенных для «пользователя» и по широте охвата проблем сопоставимых со Справочником. Круг затронутых в нем тем включает основные понятия, относящиеся к генеральной совокупности, случайному выбору, распределениям и их параметрам, точечному и интервальному оцениванию, статистическим гипотезам и возможностям их проверки. Отдельно рассматриваются широко применяемые методы оценивания — метод наименьших квадратов, метод наибольшего правдоподобия. В Справочнике обсуждаются также наиболее важные с точки зрения приложений статистические методы и модели: дисперсионный анализ линейных моделей, анализ временных рядов, анализ таблиц сопряженности и т. п. Отдельные главы посвящены важным методическим направлениям (например, последовательному анализу, непараметрическим методам, планированию эксперимента), научным концепциям (байесовскому подходу к статистическому выводу), конкретным приемам (фильтр Калмана и т. п.). В каждой теме авторы выделяют наиболее важное и ограничиваются им.

Справочник содержит большой фактический материал. Он дает возможность познакомиться со многими идеями, методами и правилами математической статистики, обходя утомительные математические доказательства. Работа с ним не требует специальной предварительной подготовки. Достаточно скромных знаний по высшей математике, матричной алгебре и теории вероятностей. Необходим лишь интерес к математической статистике.

Главы Справочника можно читать независимо друг от друга. Неизбежные при принятом в нем способе изложения повторы невелики. Работа с книгой не требует от читателя ежеминутного напряжения, хотя это отнюдь не «легкое чтение».

По характеру изложения материала Справочник под редакцией Э. Ллойда и У. Ледермана близок к широко известным и пользующимся большой популярностью «Справочнику по математике для инженеров и учащихся втузов» И. Н. Бронштейна и К. А. Семендяева (М.: Наука, 1986) и «Справочнику по математике» Г. Корна, Т. Корн (М.: Наука, 1984).

В «Справочник по прикладной статистике» включены только вполне разработанные и устоявшиеся методы. Из-за этого ряд развивающихся направлений математической статистики оказался незатронутым, например устойчивые (робастные) статистические выводы, ранговый статистический анализ, нестандартные модели регрессии, разведочный анализ данных, целенаправленное проектирование и т. д.

Сведения по вопросам, не охваченным Справочником, можно найти в трех книгах М. Дж. Кендалла и А. Стьюарта «Теория распределений» (М.: Наука, 1966), «Статистические выводы и связи» (М.: Наука, 1973), «Многомерный статистический анализ и временные ряды» (М.: Наука, 1976), а также в трехтомной работе С. А. Айвазяна, И. С. Енюкова, Л. Д. Мешалкина, вышедшей в издательстве «Финансы и статистика» (Прикладная статистика: Основы моделирования и первичная обработка данных. 1983; Прикладная статистика: Исследование зависимостей. 1985; Прикладная статистика: Классификация и снижение размерности, 1988).

Дополнительный интерес для читателя представляет то обстоятельство, что настоящий Справочник отражает своеобразие английской школы математической статистики, основы которой заложили Ф. Гальтон, К. Пирсон, Р. Фишер. Этой школе свойственно меньше следовать в русле господствующих идей теории принятия решений, а больше полагаться на здравый смысл и вероятностную интуицию.

Остается сделать несколько технических пояснений.

Материал Справочника условно разделен на шесть категорий: 1) определения; 2) теоремы, предложения, леммы, следствия; 3) уравнения и другие строчные формулы; 4) примеры; 5) рисунки и графики; 6) таблицы. Внутри каждого раздела элементы одной категории нумеруются последовательно. «Адрес» каждой выделенной категории состоит из трех цифр: номера главы, номера раздела и номера элемента (внутри раздела). Например, в разделе 5 гл. 3 мы можем найти строчную формулу (3.5.7), но также и лемму 3.5.7, за которой может последовать теорема 3.5.8. Ссылки заключены в квадратные скобки и содержат сведения о категории. Так, например, могут встретиться указания [см. (3.4.5)], что означает обращение к формуле (3.4.5), и [см. теорему 2.4.6]. Ссылки на другие тома серии «Handbook of Applicable Mathematics» построены по тому же принципу и, кроме того, снабжены номером тома (римская цифра).

7

В конце каждой главы приведена дополнительная литература. Составители Справочника стремились ограничиться немногими книгами и статьями. К этому списку были добавлены некоторые работы на русском языке, в том числе имеющиеся переводы книг, указанных в Справочнике.

Математико-статистические методы используются в самых различных областях. В экономике, например, широко применяется регрессионный анализ; в социологии и медицине проводятся выборочные обследования; все шире внедряются статистический контроль качества продукции, анализ социально-экономических данных с помощью многомерных статистических методов, методы планирования экспериментов в науке и технике.

Специалисты многих отраслей народного хозяйства остро нуждаются в справочных руководствах по прикладной статистике. Поэтому можно надеяться, что настоящий Справочник окажег им существенную практическую помощь.

С. А. Айвазян, Ю. Н. Тюрин

Глава I

ВВЕДЕНИЕ В СТАТИСТИКУ

1.1. СМЫСЛ ПОНЯТИЯ «СТАТИСТИКА»

В Оксфордском словаре английского языка приведено следующее разъяснение термина «статистика»: собранные и классифицированные числовые данные и сведения. Таким образом, можно говорить о статистике образования, финансовой статистике, статистике промышленности и т. д.

В том же словаре дается и другое разъяснение этого термина: в более старой трактовке статистика — один из разделов науки об управлении государством, сбор, классификация и обсуждение сведений о состоянии общества и государства. В настоящее время — наука, изучающая методы сбора и обраоотки фактов и данных, относящихся к человеческой деятельности и природным явлениям.

Итак, устаревшее определение, если его освободить от связи с государством, окажется не слишком отличающимся от современного толкования. Это «современное» определение удивительно старомодно, поскольку в нем не отражен ключевой аспект — интерпретация данных.

Определение, вполне приемлемое для большинства практических работников, можно сфбрмулировать, перефразировав приведенное в Оксфордском словаре: в настоящее время статистика — наука, изучающая методы сбора и интерпретации числовых данных. Здесь интерпретация данных рассматривается как существенный аспект.

Трудно дать краткое и в то же время исчерпывающее определение статистики — дисциплины с такой широкой и разнообразной областью приложения. Однако в первом приближении можно сказать, что главная цель статистики — получение осмысленных заключений из несет засованных (подверженных разбросу) данных.

* А вот определение из БСЭ. «Математическая статистика — раздел математики, посвященный математическим методам систематизации, обработки и использования статистических данных для научных и практических выводов. При этом статистическими данными называют сведения о числе объектов в какой-либо более или менее обширной совокупности, обладающих теми или иными признаками». (См.: БСЭ. — 3-е изд. — М.: Советская энциклопедия, 1974. — Т. 15. — С. 1428.) — Примеч. ред.

Действительно, исключая тривиальные ситуации, реальные данные всегда являются несогласованными, что требует применения статистических методов. Рассогласованность (разброс) между индивидуальными наблюдениями может быть, например, обусловлена ошибкой, как при считывании позиции указателя, когда он расположен между двумя делениями шкалы прибора. Изменчивость может быть также следствием флуктуаций во внешней среде, как, например, в случае мерцания звезд из-за флуктуаций в атмосфере, или следствием неравномерности работы электронного оборудования при передаче сообщений по радио или телеграфу. (В последнем случае для характеристики ситуации используется термин «шум».) Можно еще привести пример обследования части генеральной совокупности, индивидам которой присуща врожденная изменчивость измеряемой характеристики (например, рост двадцатилетних студентов мужского пола).

Чаще всего ситуация слишком сложна, чтобы ее можно было изучить на основе полного описания, отражающего все детали. Поэтому обычно применяется некоторая математическая модель явления. Она, по замыслу, должна воспроизводить его существенные черты и исключать те, которые предполагаются несущественными. Такая модель использует законы науки, приложимые к рассматриваемой ситуации, и обычно включает в себя детерминистские и стохастические (случайные) элементы. Последние в свою очередь представлены некоторой вероятностной моделью, необходимой для объяснения математической модели и проверки истинности того, что статистические выводы, строго говоря, применимы.

Пример 1.1.1. Молоко и вес детей. Рассмотрим, влияет ли регулярное потребление молока на физическое развитие школьников. Прежде чем попытаться получить ответ, мы должны решить, какое количество молока (полпинты в день?) должно быть взято, за какой период (год?), какого возраста дети (9^,-10 у лет?) и какой аспект

(или аспекты) их физического развития должен быть измерен (их вес?). Простой метод взвешивания детей до и после периода регулярного потребления молока непригоден, так как при этом невозможно отделить приращение веса, обусловленное потреблением молока, от того, которое произошло независимо от его потребления. Чтобы выявить эти составляющие, необходимо сравнить группу детей, находящихся на молочной диете, с контрольной группой детей с обычным режимом питания (который должен быть определен). Для отнесения детей к группе с молочной диетой и к контрольной группе можно было бы применить какой-либо из методов, предполагающих процедуры рандомизации, что позволило бы рассматривать индивидуальные изменения веса как реализации независимых случайных величин [см. II, определение 4.4.1]. В первом приближении, но с достаточной точностью эти изменения веса могли бы рассматриваться как нормально распределенные [см. II, раздел 11.4] со стандартным отклонением о и с математическим ожиданием для группы детей с обычным режи

10

мом питания и д2 для группы детей с молочной диетой. Здесь ци ц2 на — неизвестные параметры. Подходящие приближения для их значений, называемые «оценками», могли бы быть выведены из данных. Исходный вопрос «Ведет ли увеличенное потребление молока к возрастанию веса?» превращается в следующий: «Является ли различие между оценками gi и д2 значимым, т. е. достаточно ли оно велико, чтобы позволить нам учесть случайные эффекты и заключить, что g2 действительно больше, чем и если это так, то сколь значительно и насколько точно оценено различие?».

Это в принципе простой пример, но он иллюстрирует некоторые главные черты статистического вывода. Прежде всего сбор данных должен быть организован так, чтобы выполнялись требования теории вероятностей: обследование должно быть правильно спланировано, и выборочный метод должен соответствовать поставленной цели. Далее характеристики жизни детей, несущественные для исследования, необходимо исключить из рассмотрения. Тогда модель будет основана на упрощающем предположении, что при правильном планировании вариабельность может быть объяснена в терминах выбранного семейства распределений [см. II, гл. 4 и 11]. Выбор такого семейства (нормального в нашем примере) является результатом компромисса между сложностью реальности и простотой, необходимой для получения правильных количественных заключений с наименьшими вычислительными трудностями. Чтобы гарантировать истинность этого выбора, возможно, понадобятся дальнейшие исследования. В рассмотренном примере модель проста: наблюдениями является вес детей, а в качестве исследуемого эффекта взято различие между конечным и исходным весом. В хорошо разработанном эксперименте наблюдения могли бы быть выражены в виде более сложных функций переменных и/или параметров, предлагаемых или необходимых в данной области науки. Некоторые (или все) из этих переменных могли бы рассматриваться как подверженные случайному разбросу, что требует толковать их как случайные переменные. Могли бы быть подобраны подходящие семейства распределений и оценены соответствующие параметры. Затем, как и в вышеприведенном примере, следовала бы процедура, подтверждающая пригодность модели в целом.

Например, наблюдениями могло бы быть количество осадков, измеряемых в 20 соседних городах за каждый из 100 последовательных четвертьчасовых интервалов. Модель, основанная на радиометеорологии, могла бы связать осадки в данном месте как функцию времени с зарождением, ростом, распадом облачных масс. В качестве переменных тогда можно было бы использовать темп зарождения облачности (возможно, как двумерный пуассоновский процесс [см. II, раздел 20.1.7]) и параметры, описывающие форму облаков и скорость их роста и распада.

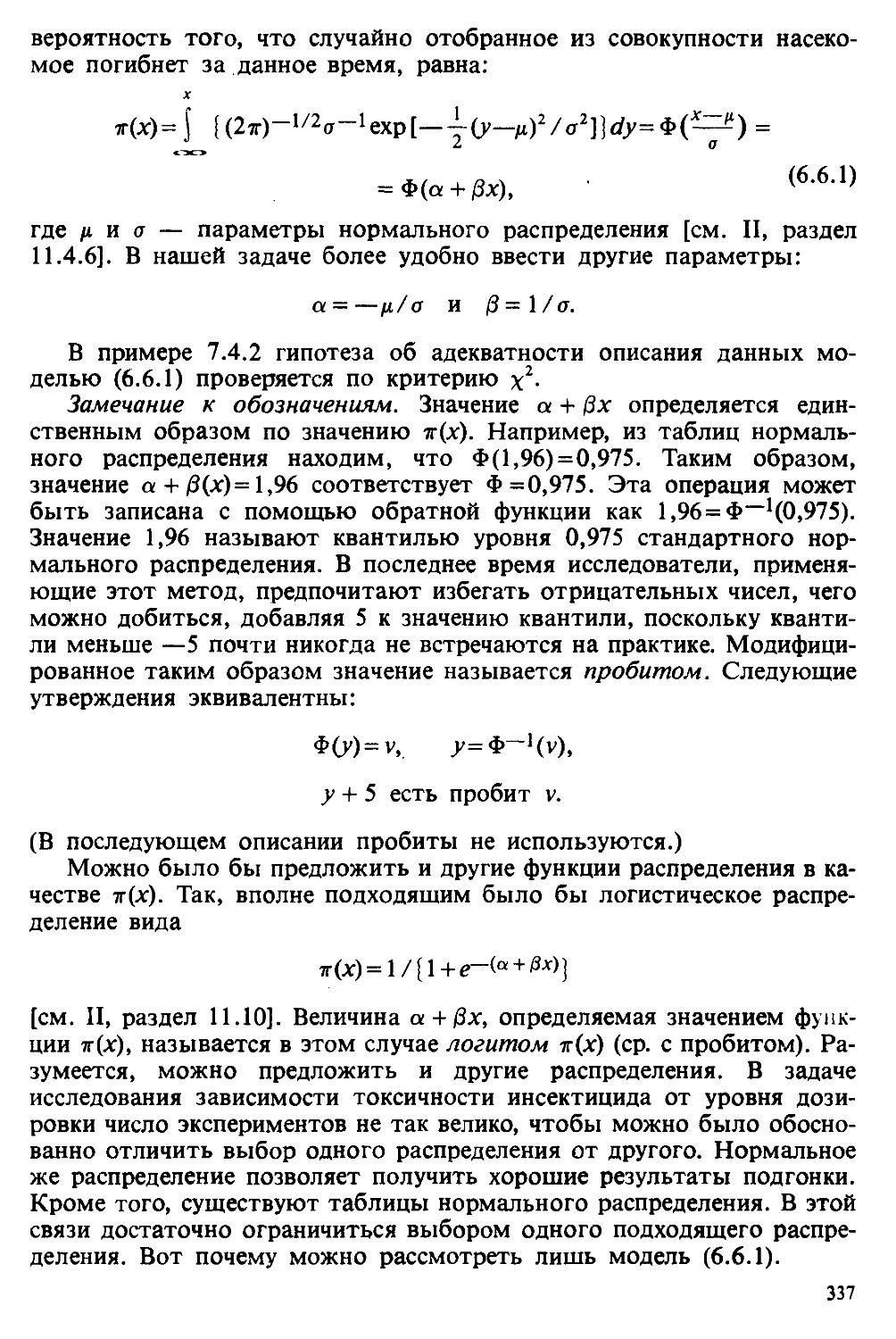

Пример 1.1.2. Эксперимент по определению смертельной дозы инсектицида. Другой пример, детально описанный в разделе 6.6, связан с оценкой смертности насекомых в зависимости от дозы применяе

11

мого инсектицида. Действие различных доз инсектицида измеряется числом насекомых, погибших после применения соответствующей дозы. При очень низкой дозировке насекомые не погибают, при очень высокой погибают все. В то же время при промежуточных дозах процент погибших насекомых, который подвержен экспериментальному разбросу и зависит от многих факторов, в среднем возрастает с увеличением дозы. Необходимо: а) подобрать правдоподобную параметрическую модель для описания «кривой роста» доли погибших насекомых в зависимости от дозировки; б) оценить параметры этой кривой и проверить, что результирующая кривая действительно является приемлемой моделью; в) получить значение дозировки, при которой погибает 50% насекомых (эта величина будет служить принятой мерой токсичности), вместе с оценкой ее надежности.

Приведенный пример показывает, что нам необходимы методы для получения хороших приближенных значений параметров («оценок»), характеризующих член выбранного семейства вероятностных распределений, а также методы для описания точности этих оценок. Оценка точности должна подсказать, являются ли различия в оценках параметров настолько значимыми, чтобы можно было говорить о различиях между действительными (неизвестными) значениями параметров. Она необходима также для того, чтобы проверить, дает ли избранное семейство распределений приемлемую модель для наблюдаемых данных. Таковы наиболее важные черты статистического вывода. Они детально описаны в последующих главах настоящего Справочника наряду с некоторыми другими подходами, основанными на них. Введение в статистический вывод содержится в работе [Barnett (1982), гл. 1].

1.2. ВЫБОРОЧНОЕ РАСПРЕДЕЛЕНИЕ, СТАТИСТИКА, ОЦЕНКА

Как было отмечено в разделе 1.1, при статистическом подходе вопросы, относящиеся к реальному миру, превращаются в какой-то мере эквивалентные им вопросы о свойствах вероятностных распределений в принятой статистической модели. Так, влияние молока на вес детей обсуждалось в терминах значения параметра в (или набора параметров) вероятностного распределения, описывающего прирост веса отдельных детей. В исследование было включено конечное число детей, и они, или, точнее, приросты их веса, образуют выборку. Эта выборка, скажем, объема п позволяет получить п единиц данных, а именно индивидуальные приросты веса xif х2.хп. Мы будем полагать, что

выборка — это тот набор данных, который только и доступен статистику. Следовательно, оценка значения неизвестного параметра О (для простоты полагаем, что параметр только один), которую может получить статистик, должна быть вычислена по определенному правилу из выборочных величин хь х2....хп, скажем,

О* = tn (xltx2.хп). (1.2.1)

12

Например, есть веские основания взять в качестве оценки 0* выборочное среднее

(*! 4- Х2 4- ... 4- Хп) / П.

Любая подобная комбинация наблюдаемых значений называется статистикой (итак, это расширяет значение слов «статистика» по сравнению с его нетехническим употреблением, когда оно означало сбор данных или фактов). Статистика — это число, вычисленное по выборке. Если оно используется как оценка величины параметра 0, то статистика должна быть в некотором смысле приближенным значением для 0. Вопрос в том, в каком смысле?

Пытаясь ответить на этот вопрос, мы должны вспомнить, что частное значение статистики, которое нам удалось получить по выборке приростов веса детей, могло бы измениться, если бы мы взяли другую группу детей. Действительно, если вывод, который мы надеемся получить, должен быть использован для более расширенной группы детей, чем та, которая включена в нашу выборку, существенно, чтобы эта выборка была извлечена из этой расширенной группы с помощью метода, включающего элементы случайного выбора. На вопрос о том, является ли наша оценка хорошей, можно ответить в терминах, относящихся к широкому классу оценочных правил (1.2.1), которые возникают в выборочных процедурах.

Пример 1.2.1. Контроль качества в промышленности. Пусть имеется партия из 10000 номинально идентичных изделий. Известно, что некоторые из этих изделий дефектны: их критические размеры лежат вне допустимых границ. Требуется оценить долю (скажем, 0) дефектных изделий в партии на основе результатов точного измерения размеров, проведенного на выборке из 20 изделий, взятых из партии.

Рассмотрим сначала процедуру формирования выборки. Предположим, что она организована следующим образом: 20 изделий должны быть выбраны «случайно», т. е. таким образом, чтобы при каждом акте выбора все изделия в партии имели бы одинаковый шанс быть отобранными. (Этого не всегда легко достигнуть, и практические способы различны в зависимости от объема партии и свойств изделий.) Так как в нашем случае партия очень велика по сравнению с объемом выборки, доля дефектных изделий в ней после извлечения выборки не будет существенно отличаться от исходной доли в. В этих условиях статистические свойства нашей выборки практически неотличимы от свойств выборки, полученной с помощью процедуры «случайного выбора с возвращением» [см. II, раздел 3.6.3]. Следовательно, с приемлемой степенью точности вероятность того, что наша выборка содержит г дефектных изделий, г = 0, 1, 2..19 или 20, определяется

по формуле биномиальной вероятности [см. II, раздел 5.2.2]:

С?) 0" (1 — 0)м’г. (1.2.2)

13

Обратимся теперь к оценке. Критерии для формулирования правил, позволяющих получать «хорошие» оценки, обсуждаются ниже (см. гл. 3); сейчас же мы будем основываться на интуитивном представлении о том, что доля дефектных изделий в выборке кажется разумным приближением к доле дефектных изделий во всей партии. Следовательно, мы принимаем в качестве оценки для 9 число 9*, определенное как

О* = /720, (1.2.3)

где г — число дефектных изделий в выборке (объема 20). Если наблюдаемое значение г = 8, то

9* = 0,40.

Выражение (1.2.3) есть специальный случай (1.2.1); оно дает некоторое правило для получения оценки из выборочных данных. Теперь согласно (1.2.2) значение г в (1.2.3) представляет собой реализацию [см. II, гл. 4] случайной переменной R, распределенной по биномиальному закону Bin (20,0) [см. II, раздел 5.2.2]. Следовательно, 9* есть реализация некоторой случайной величины, скажем Т, где

Т = R/20, (1.2.4)

ее возможные значения —

0,1/20,2/20...19/20,1.

Согласно (1.2.2) ее распределение вероятностей определяется формулой

Р(Т = /720) = P(R/20 = /720) =

= P(R = г)=(“ )9Г(1 — 0)2О Г, г = 0,1.20. (1.2.5)

В этом примере вопрос «Какова доля дефектных изделий в партии?» был заменен вопросом «Каково значение параметра 9 распределения вероятностей (1.2.2)?». Оценка 0*=О,4О рассматривается как реализация случайной величины Т, распределение которой приведено в (1.2.5). Случайную величину, реализацией которой является оценка, будем называть оценивателем (estimator). Соответствующее распределение вероятностей называется выборочным распределением оценки (или оценивателя). (Аналогичный смысл придается выборочному распределению любой статистики независимо от того, может ли она непосредственно использоваться как оценка.)

Приведенные рассуждения наводят на мысль, что вопрос «Является ли 0* хорошей оценкой 0?», можно рассматривать как сокращенную форму другого вопроса: «Высока ли вероятность того, что согласно выборочному распределению 0* его наблюдаемое значение близко к 0?». В примере, который обсуждался выше, мы можем, не-

* В русском языке нет специального названия для этой величины, поэтому здесь мы следуем английскому образцу. — Примеч. ред.

14

Вероятность

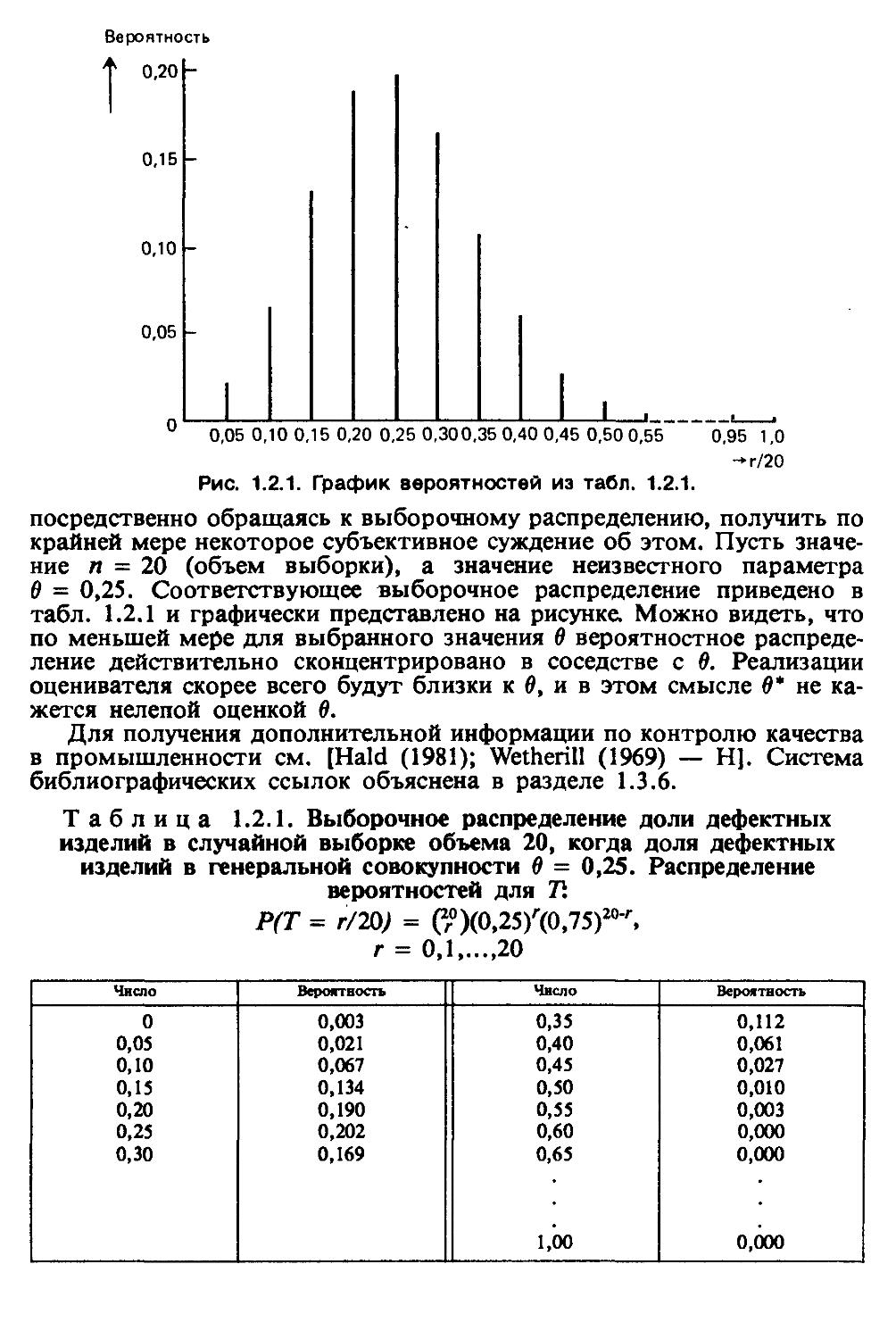

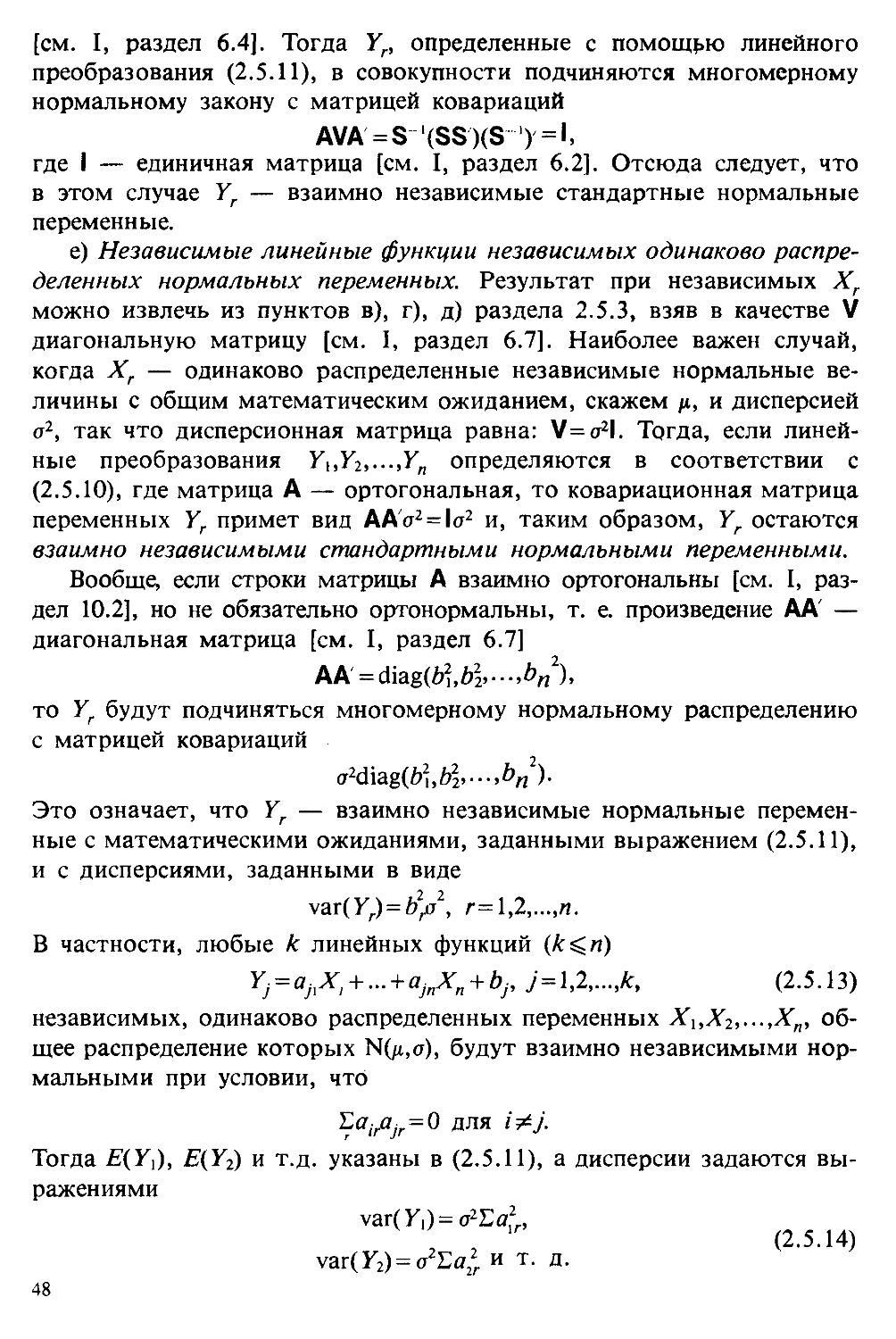

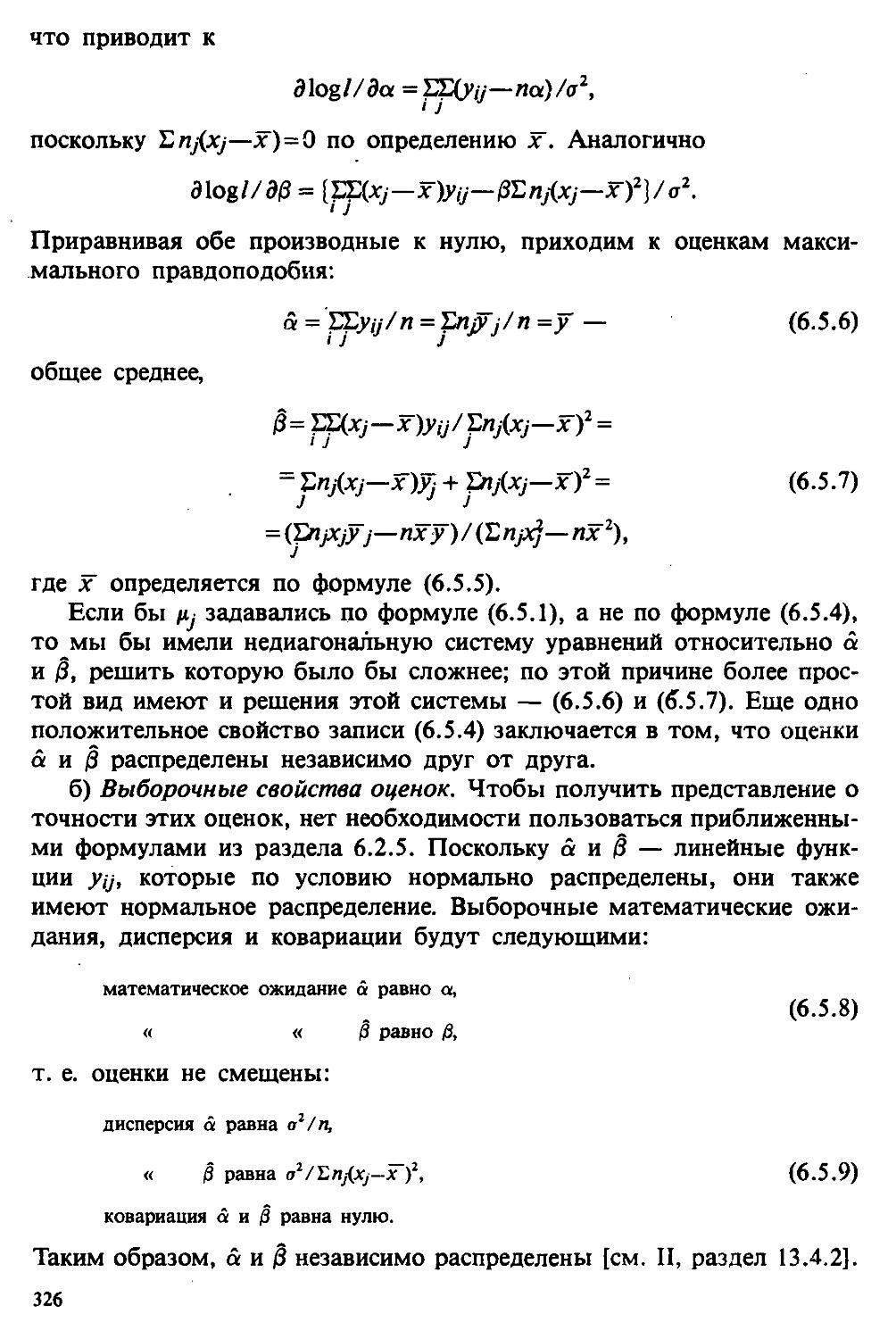

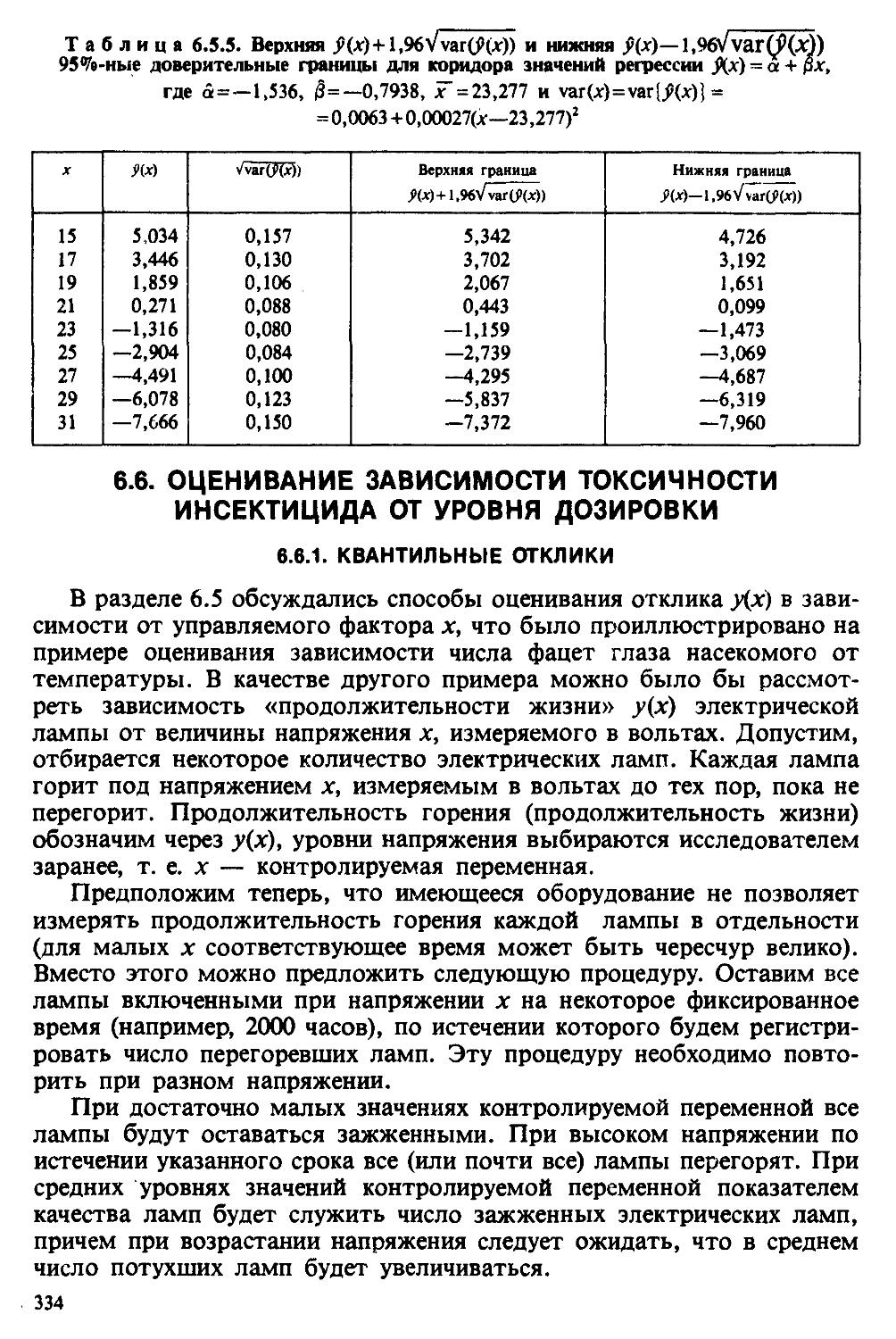

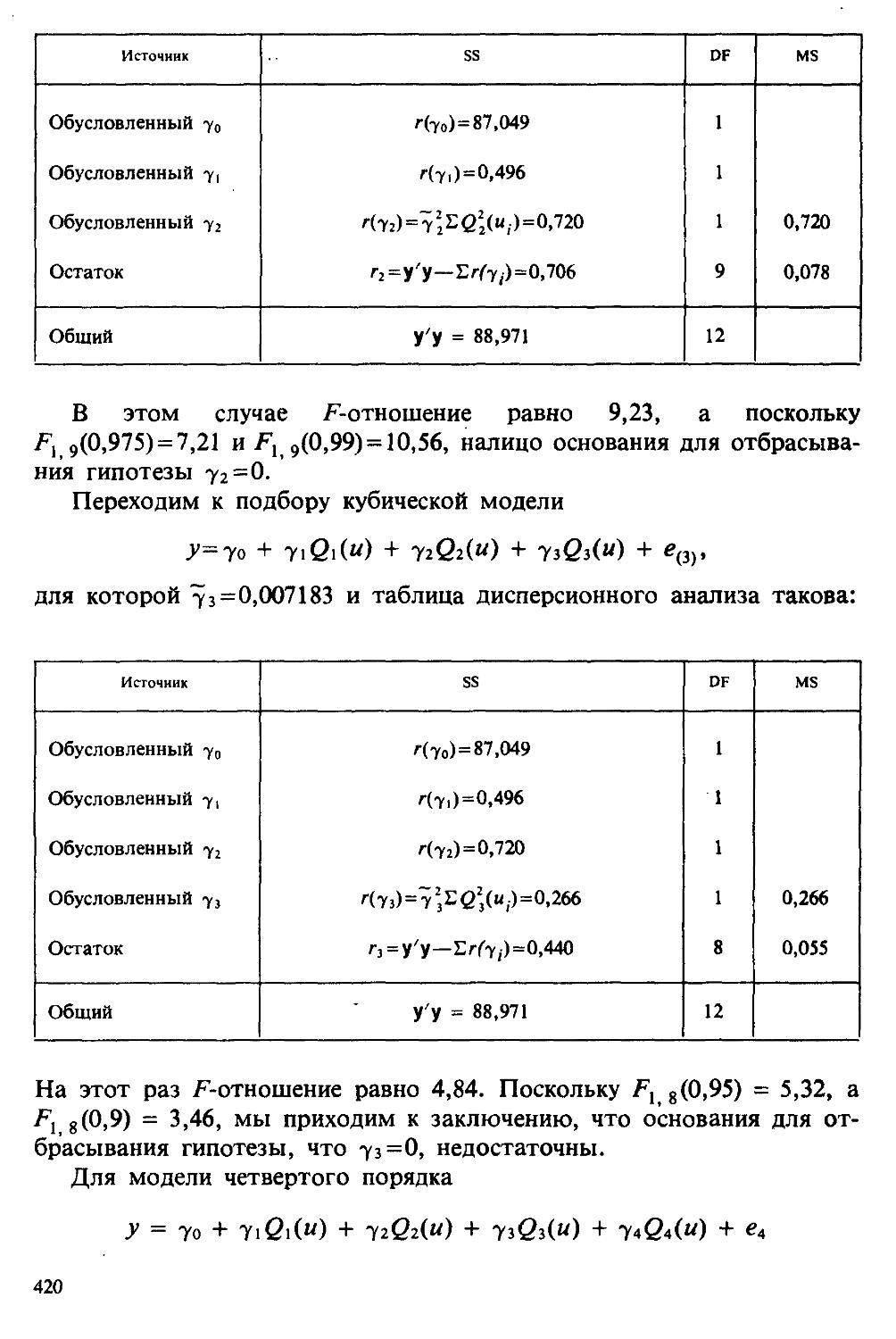

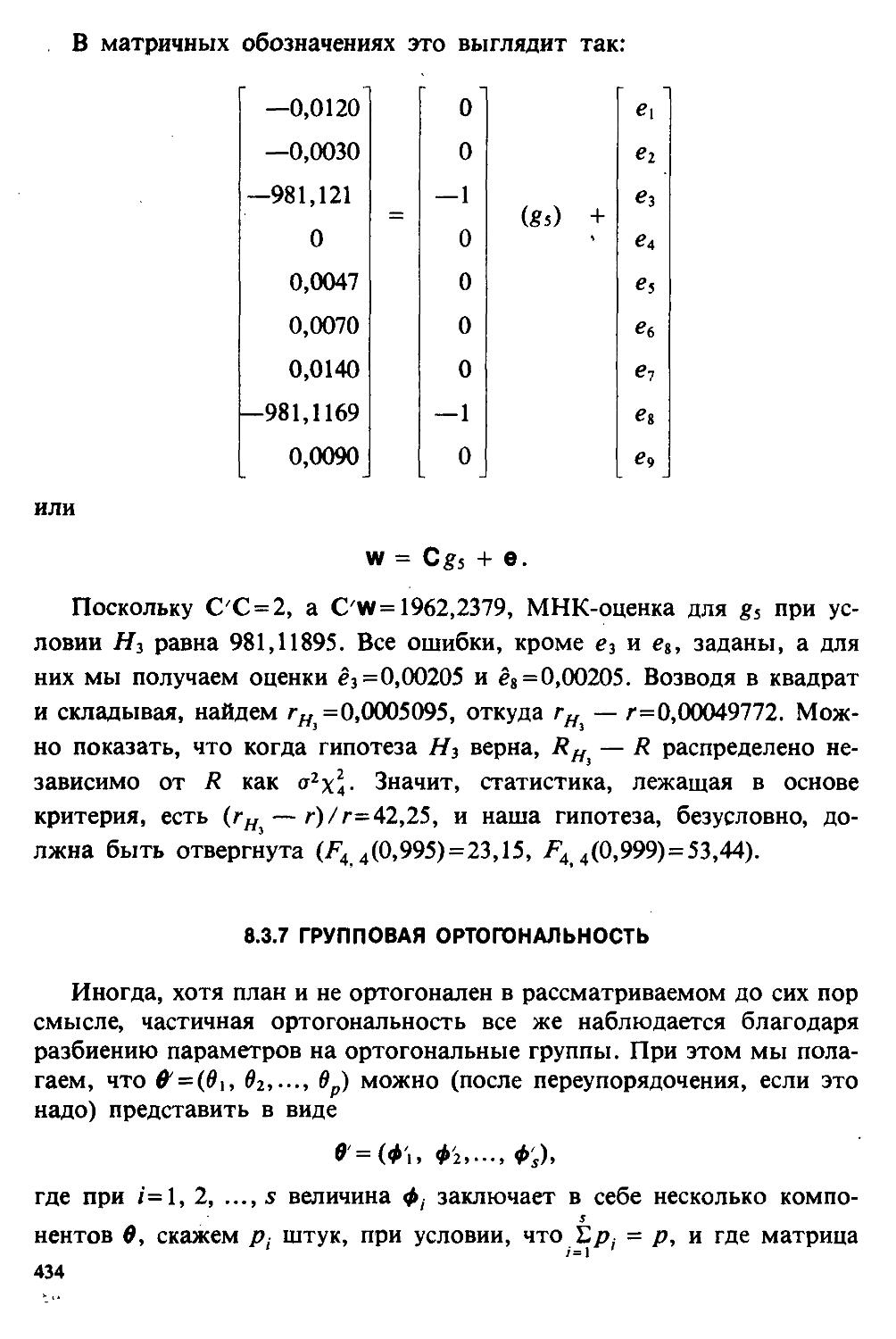

посредственно обращаясь к выборочному распределению, получить по крайней мере некоторое субъективное суждение об этом. Пусть значение п = 20 (объем выборки), а значение неизвестного параметра О = 0,25. Соответствующее выборочное распределение приведено в табл. 1.2.1 и графически представлено на рисунке. Можно видеть, что по меньшей мере для выбранного значения 6 вероятностное распределение действительно сконцентрировано в соседстве с 0. Реализации оценивателя скорее всего будут близки к 6, и в этом смысле О* не кажется нелепой оценкой 6.

Для получения дополнительной информации по контролю качества в промышленности см. [Hald (1981); Wetherill (1969) — HJ. Система библиографических ссылок объяснена в разделе 1.3.6.

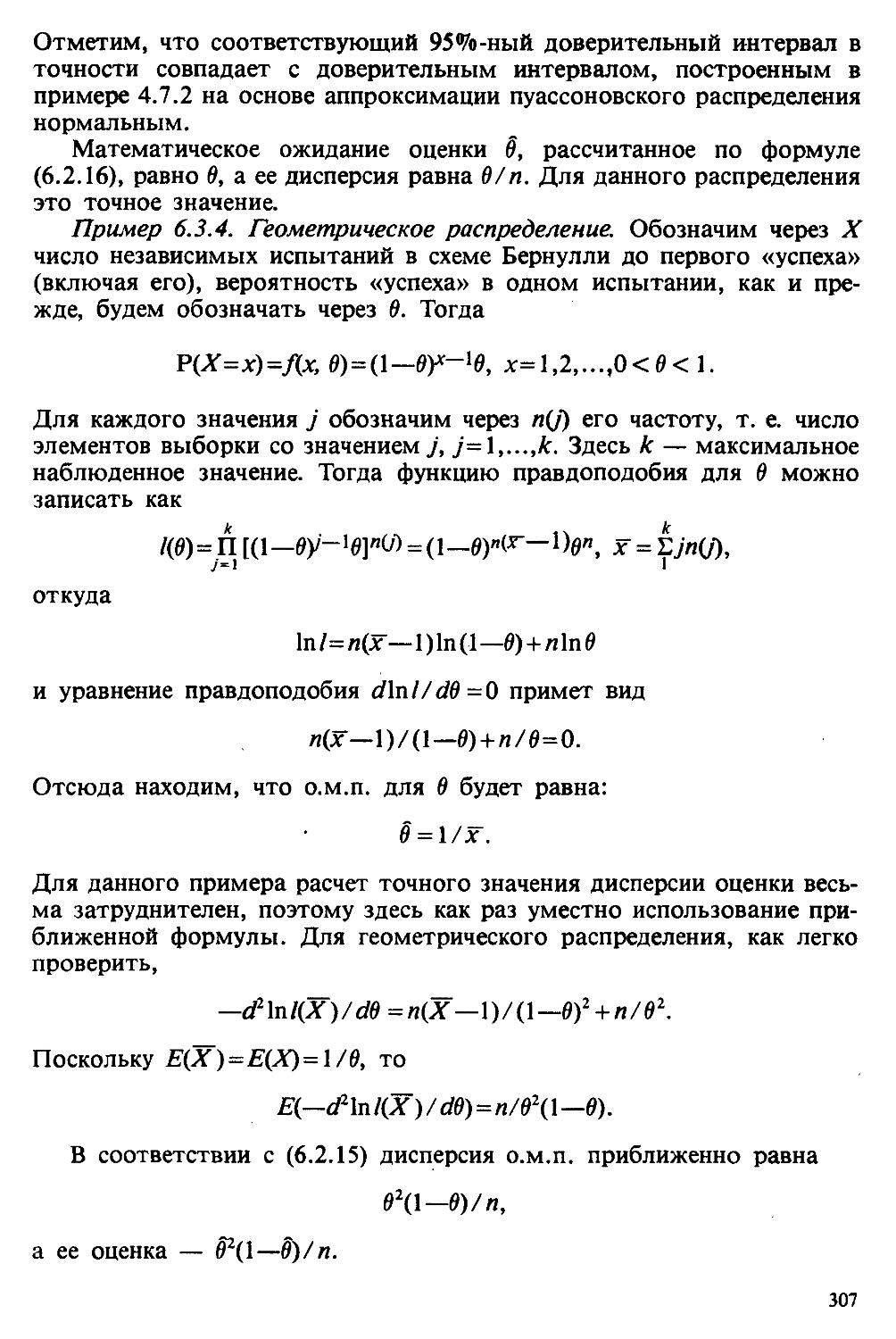

Таблица 1.2.1. Выборочное распределение доли дефектных изделий в случайной выборке объема 20, когда доля дефектных изделий в генеральной совокупности 6 = 0,25. Распределение вероятностей для 71

Р(Т = г/20; = (2°)(0,25)г(0,75)20'г»

г = 0,1...20

Число Вероятность Число Вероятность

0 0,003 0,35 0,112

0,05 0,021 0,40 0,061

0,10 0,067 0,45 0,027

0,15 0,134 0,50 0,010

0,20 0,190 0,55 0,003

0,25 0,202 0,60 0,000

0,30 0,169 0,65 0,000

1,00 0,000

1.3. ТЕМА ЭТОЙ КНИГИ

Хотя термин «статистика» значительно шире, чем «прикладная теория вероятностей», концепции и методы статистики тесно связаны с концепциями и методами теории вероятностей. Возможно, идеальным было бы развитие теории вероятностей и статистики как единой интегрированной дисциплины. В серии «Handbook of Applicable Mathematics», однако, было решено посвятить один том (т. И) теории вероятностей и один том (т. VI) статистике. Это не означает, конечно, что том II целиком должен быть изучен перед попыткой обратиться к настоящему тому! Напротив, методы, изложенные здесь, чаще всего понятны читателю и реже требуются лишь отдельные сведения по основам теории вероятностей. Во всех случаях, когда такие сведения необходимы, даются ссылки на соответствующие разделы тома II. Аналогии-ю обсушл дело с ссылками на другие тома серии «Handbook of Applicable Mathematics».

Очевидно, что и теория вероятностей, и статистика имеют свой круг проблем. Одя&ко среди них есть общие для обеих этих дисциплин. Например, в нашем случае вопрос относительно независимости квадратичных форм нормально распределенных случайных величин, который мог бы прекрасно вписаться в том, посвященный теории вероятностей, в действительности был признан как имеющий большой интерес для статистики и рассмотрел в настоящем Справочнике. То же относится к центральным распределениям (см. раздел 2.8).

Тематика, охваченная Справочником, кратко представлена в разделах 1.3.1—1.3.5, в то время как в разделе 1.3.6 перечислены некоторые проблемы, не рассмотренные здесь.

Прежде чем приступить к краткому описанию содержания, необходимо сказать несколько слов о порядке изложения материала.

Одна из основных целей серии «Handbook of Applicable Mathematics» состоит в том, чтобы предоставить читателю удобный подбор математических процедур и результатов. Казалось бы, расположение материала в алфавитном порядке, как в энциклопедии, наилучшим образом соответствовало бы указанной цели. Однако такой порядок привел бы к большому числу довольно коротких и сильно взаимосвязанных разделов. Принимая в расчет частично упорядоченную структуру математики, издатели считают, что группирование материала в однородные по содержанию главы больше отвечает поставленной цели: это обеспечивает бблыпую непрерывность и осмысленность изложения, как в традиционных учебных курсах, а благодаря развитой системе перекрестных ссылок сохраняет и преимущество энциклопедии. Однако поскольку эта книга не является учебным пособием, расположение материала в ней достаточно произвольно, ссылки даются как на более поздние главы, так и на более ранние. В частности, гл. 2 содержит материал, относящийся к выборочным распределениям, которые связаны с тематикой, рассмотренной позднее. Каждая из других глав

16

представляет какую-либо одну важную тему. В одном или двух случаях было признано удобным разделить материал, относящийся к одной, главной, теме, на две главы.

Теперь рассмотрим кратко содержание Справочника.

1.3.1. ВЫБОРОЧНЫЕ РАСПРЕДЕЛЕНИЯ. МЕТОДЫ, СВОБОДНЫЕ ОТ РАСПРЕДЕЛЕНИЯ

Статистик должен получить свои выводы, используя наличную выборку. Каждое наблюдение является реализацией случайной величины. Известно множество значений, которые может принимать случайная величина; некоторые из них имеют ббльшую вероятность появления, чем другие. Значение, которое наблюдалось, представляет собой реализацию. Вероятности возможных реализаций характеризуются распределением вероятностей случайной величины. В исключительных случаях вероятность реализации может быть указана в виде числа, определяемого из распределения вероятностей. Но обычно функции распределения вероятностей бывают заданы с точностью до одного-двух параметров, значения которых не известны. Это приводит к проблеме поиска таких комбинаций выборочных значений, которые бы давали наилучшее приближение для неизвестных параметров. Каждая такая комбинация есть статистика, и, как и любое наблюдаемое значение, статистика представляет собой реализацию некоторой случайной величины. Если х2 и х3 — независимые наблюдения из распределения Ы(д,а) с математическим ожиданием д и стандартным отклонением а (это параметры семейства нормальных распределений), то мы можем рассматривать Xi как реализацию случайной величины Xit х2 — как реализацию случайной величины Х2 и х3 — как реализацию Х3, где Х\, Х2 и Х3 — независимые случайные величины, распределенные согласно N (д, а). Мы можем назвать Xt случайной величиной, индуцированной хх, Х2 — индуцированной х2 и Х3 — индуцированной х3. Статистика х = (xt +х2+х3)/3, так называемое выборочное среднее, есть реализация случайной величины X = (Xi+X2+X3)/3, которая может рассматриваться как индуцированная х. Из свойств нормального распределения [см. II, раздел 11.4.5] следует, что распределение вероятностей для индуцированной случайной величины X есть Ы(д,(т/73). Это — выборочное распределение статистики х, которое с точностью до д и а позволяет судить о вероятностях различных значений реализаций X (конечно, одно из них есть значение статистики х, полученное по нашей выборке). В частности, соответствующая плотность вероятностей достигает максимального значения при д, и поэтому х представляет собой разумную оценку для д. С помощью выборочного распределения можно также получить и вероятность того, что наше значение х расположено от д на расстоянии, большем, чем заданное (в масштабе о).

Итак, выборочное распределение статистики позволяет судить, может ли предложенная статистика служить оценкой интересующего нас параметра.

(Здесь, как и всюду в книге, мы использовали соглашение об обозначениях, согласно которому случайные переменные обозначаются прописными латинскими буквами (например , X), а реализации этой случайной переменной — строчными латинскими буквами (например, X, ИЛИ Xi, ИЛИ А';).)

Выборочное распределение, таким образом, весьма важно. Поэтому в книге выделена глава, где сосредоточена информация о выборочных распределениях статистик, имеющих большое значение для практики.

Однако статистические процедуры, которые сильно зависят от выборочных распределений, могут быть подвергнуты критике, поскольку выборочные распределения статистик зависят от предположений относительно распределений, лежащих в основе самой вероятностной модели. Если эти предположения не выполнены, то конструкция в целом нарушается. На практике наиболее широко используемые процедуры являются устойчивыми (робастными), т. е. сравнительно нечувствительны к тем отклонениям от вероятностной модели, которые не выходят за пределы разумно допустимых.

Ясно, что наиболее устойчивыми среди всех процедур будут такие (если они существуют), которые эффективны без каких-либо предположений о распределении. Такие процедуры в самом деле существуют и называются свободными от распределения (или непараметрическими). Эти методы рассмотрены в гл. 14.

1.3.2. ОЦЕНКИ, ТЕСТЫ, РЕШЕНИЯ

Обманчиво короткий заголовок этого раздела соответствует тому, что в действительности составляет большую часть данной книги.

Проблема оценивания была схематично описана в разделе 1.3.1. Гл. 3 расширяет это описание и подводит к систематическому подходу, позволяющему находить хорошие оценки. В ней рассмотрены и графические методы представления информации, содержащейся в выборке, а также некоторые формальные критерии, например, оценка параметра должна иметь ту же физическую размерность, что и оцениваемый параметр, оценка должна быть связана с интересующим нас параметром, а нс с другими параметрами, оценка должна иметь возможно меньшую вариабельность (измеренную ее стандартным отклонением).

Оказывается, что в некоторых случаях можно сконцентрировать всю информацию относительно некоторого параметра, содержащуюся в выборке, в одной («достаточной») статистике. Эта концепция также обсуждается в гл. 3, в конце которой есть и короткий раздел, посвященный практическим приемам конструирования оценок, имеющих желательные свойства.

Ясно, что разумная процедура оценивания не должна ограничиваться лишь выбором приближенного численного значения для неизвестного параметра; она должна что-то говорить и о надежности этого приб-18

лижения. Хотя эти два аспекта единой проблемы оценивания тесно связаны, иногда удобно обсуждать их отдельно. Соответственно мы говорим о точечном оценивании и об интервальном оценивании. Гл. 4 в основном посвящена интервальному оцениванию. В ней рассматриваются: а) «доверительные интервалы», связанные с поведением статистик в повторных выборках, теория которых сильно зависит от выборочных распределений; б) правдоподобные интервалы, один из аспектов функции правдоподобия, которая позволяет среди всех возможных значений параметра выделить правдоподобные с учетом имеющихся данных (выборки); в) байесовские интервалы, сконструированные на основе подхода, при котором выборка рассматривается как средство для изменения и уточнения априорной информации, имеющейся в наличии до получения выборки (этот подход подробно обсуждается в гл. 15).

Поскольку в целом статистика как научная дисциплина основана на идее случайной изменчивости, каждая оценка подвержена ошибке; если получены две различные оценки параметра — одна при одном наборе условий, а другая при другом, — непосредственно не ясно, соответствует ли имеющееся между ними различие различию между параметрами. Например, параметром может быть вероятность определенного заболевания при приеме препарата А (одно условие) или препарата В (другое условие). Вопрос об их различии решается с помощью статистического критерия (теста) или критерия значимости; эта процедура описана в гл. 5.

Один из подходов к статистическим критериям (проверке гипотез) связан с именем Р. А. Фишера [см. Box (1978) — D], который рассматривает проверку гипотезы как пробный шаг в проведении научного исследования, позволяющий получить ученому объективный критерий, с помощью которого можно судить об истинности гипотезы. Другой подход связан в основном с именами Дж. Неймана и Э. Пирсона, которые рассматривают процедуру проверки гипотезы как правило, с помощью которого должен быть сделан выбор между одним способом действия и другим либо принято решение об истинности одной гипотезы в противовес другой. В обычной статистической практике реальные процедуры при этих двух подходах не очень различаются. Сравнительно недавно теория принятия решений стала самостоятельной дисциплиной, задачей которой является анализ потерь и выигрышей при принятии неправильных и правильных решений. Достижения этой дисциплины важны и полезны в теории оценивания, проверке статистических гипотез и в других областях. Эти вопросы обсуждаются в гл. 19.

Одна из частных проблем теории проверки статистических гипотез — оценка пригодности вероятностной модели, предложенной для объяснения данных. С достаточным основанием можно предположить, что некоторая последовательность нерегулярно возникающих событий (например, отсчетов счетчика Гейгера) представляет собой пуассоновский процесс (см. II, раздел 20.1). После того как интересующий нас

19

параметр оценен по имеющимся данным, возникает вопрос, насколько предложенная модель соответствует выборке. Являются ли выборочные значения действительно близкими к тем, которые можно ожидать, используя подогнанную модель? Наиболее широко применяемая для решения подобного вопроса процедура позволяет вычислить некоторую статистику, введенную Карлом Пирсоном, и воспользоваться критерием, основанным на ее выборочном распределении. Это пирсо-новский критерий согласия хи-квадрат (х2), описанный в гл. 7.

Существуют различные методы конструирования «точечных» оценок и определения их надежности. Наиболее полезен из них метод максимального правдоподобия, который обсуждается в гл. 6. Там же приведены и примеры его применения. Другой известный метод, который может рассматриваться либо как специальный случай метода максимального правдоподобия, либо как независимая процедура подгонки, — метод наименьших квадратов. Этот метод и более или менее систематизированный набор правил для проверки статистических гипотез (все это называется дисперсионным анализом или сокращенно ANOVA) описаны в гл. 8.

Те методы оценивания и проверки гипотез, о которых говорилось выше, предназначены для данных, представленных «фиксированной» выборкой. Это значит, что сначала была завершена процедура выбора, а затем ее результаты были подвергнуты обработке. В некоторых ситуациях порции данных поступают последовательно. Для подобных выборочных процедур разработаны специальные методы проверки гипотез. В этих методах доказательства в пользу интересующей нас гипотезы или против нее накапливаются одновременно с ростом выборки до тех пор, пока они не станут убедительными. Тогда выборочная процедура прерывается. Такие процедуры проверки гипотез называются последовательными. Они рассматриваются в гл. 13.

Сельское хозяйство, пожалуй, в наиболее сильной степени подвержено влиянию природной изменчивости. По этой причине в ранний период своего развития сельскохозяйственная наука встретилась с большими трудностями при сравнении различных сортов семян и удобрений. Важнейшая роль сельского хозяйства, немалая стоимость и большая продолжительность полевых исследований требуют эффективного планирования действий. Это обусловило развитие планирования сравнительных экспериментов, науки (или искусства), не ограниченной теперь только сельским хозяйством.

В гл. 9 дано введение в эту обширную дисциплину, а гл. 10 посвящена методам анализа данных, получаемых в результате таких экспериментов. Эти методы основаны на линейной модели, в которой предполагается, что отклик системы (например, урожай пшеницы) в зависимости от имеющихся стимулов (например, количества удобрения) представляет собой линейную функцию. Концепция линейности может быть, впрочем, успешно расширена до более сложных моделей, нелинейных, как в большинстве случаев применения дисперсионного анализа. Например, токсичность некоторых лекарственных пре-20

паратов является нулевой, если их доза не превышает пороговой величины; затем токсичность возрастает с увеличением дозы, сначала медленно, затем быстрее, потом снова медленнее. Прирост токсичности сходит на нет при приближении к стопроцентной смертельной дозе (см. пример 1.1.2). Иногда говорят, что кривая отклика, измеряющая при установленной дозе процент погибших в эксперименте животных, имеет S-образную форму. Можно найти преобразование, которое переводит ее в прямую линию. Так несколько неожиданно мы приходим к линейной модели, для которой может быть применен метод наименьших квадратов (усложненный, однако, различием в разбросе откликов).

Такое обобщение линейной модели обсуждается в гл. 11 и 12.

1.3.3. БАЙЕСОВСКИЙ ВЫВОД

Мы уже упоминали байесовскую статистику, названную так в честь английского математика 18-го столетия Р. Томаса Байеса [см. Pearson and Kendall (1970) — D]. Если говорить просто, при байесовском подходе параметр, который должен быть оценен, рассматривают как случайную величину. В этом случае его свойства следует описывать в терминах распределения вероятностей.

При выборочном контроле в промышленности, обсуждавшемся в примере 1.2.1, доля дефектных изделий в партии оценивалась с помощью значения некоторой статистики, основанной только на выборке из этой партии. Предположим теперь, что данная партия сама представляет собой одну из множества партий, относительно которых опытным путем установлено, что доля дефектных изделий в них (0) независимо изменяется от одной партии к другой известным образом: например, в 3% партий доля дефектных изделий 0 = 0,01, в 5% 0 = 0,025 и т. д. Значение 0 для исследуемой выборки можно рассматривать как реализацию некоторой случайной величины с известным (априорным) распределением вероятностей. Используя теорему Байеса [см. II, раздел 16.10], можно скомбинировать выборочную величину с априорным распределением, чтобы улучшить вероятностные характеристики оценки (ее апостериорное распределение). Это уменьшает неопределенность вывода о значении 0 для данной партии.

При «новейшем байесовском подходе» к статистическому выводу учитывают то обстоятельство, что всегда имеется некоторая априорная информация о неизвестном параметре, возможно, менее точная, чем в случае, описанном выше, но все же достаточная для получения априорного распределения, из которого конструируется апостериорное. Эти проблемы обсуждаются в гл. 15.

1.3.4. МНОГОМЕРНЫЙ АНАЛИЗ

Только в простейших ситуациях статистик имеет дело с единственной случайной величиной. Обычно каждый объект из выборки может

быть подвергнут нескольким различным измерениям, например, можно измерить рост, обхват талии, вес человека. В этом случае статистика интересует, ведут ли себя компоненты вектора наблюдений независимо друг от друга; если нет, то как можно описать их совместное поведение; являются ли некоторые из компонентов более информативными для разделения на классы и т. д. Классический подход к решению подобных задач обсуждается в гл. 17. В гл. 18 приведен обзор современного состояния этих проблем.

1.3.5. ВРЕМЕННЫЕ РЯДЫ

Последняя тема, которой мы коснемся в этом описании разделов статистики, охваченных книгой, связана с анализом последовательности наблюдений (каждое из них подвержено случайному разбросу), порождаемых источником, который сам изменяется, развивается или флуктуирует. Такими наблюдениями могут быть, например, ежедневные измерения уровня воды в Темзе на Марлоу, еженедельное количество дождевых осадков в Сан-Франциско, ежечасные замеры концентрации определенного химиката в камере повышенного давления для какого-нибудь химического процесса, ежемесячная статистика дорожно-транспортных происшествий и т. д. Вариации в данных представляют собой смесь в неизвестных пропорциях закономерных колебаний (таких, как, например, чистый синусоидальный сезонный эффект) с флуктуациями, подчиненными некоторому (неизвестному и, возможно, изменяющемуся во времени) рапределению вероятностей. Поведение системы в момент времени t может зависеть от ее поведения в более ранние моменты t—1, t—2, ... Целью изучения такой системы обычно служит предсказание (прогноз) ее поведения.

Теория временных рядов рассматривается в гл. 18. Важный мегод, известный как фильтр Калмана, описан в гл. 20.

1.3.6. БИБЛИОГРАФИЧЕСКИЕ ССЫЛКИ

Родственные темы в книге связаны системой перекрестных ссылок. Используются также ссылки на другие тома серии «Handbook of Applicable Mathematics». Отсылки за пределы Справочника организованы по-разному: внутри глав и для тома в целом.

Список книг (литература для дальнейшего чтения) для конкретной главы приведен в конце ее. Это позволяет получить дополнительную информацию. В тексте ссылки на эти работы выглядят так: [см. Barnett (1982), гл. 1].

В т. 2 Справочника приведен общий для обоих его томов список литературы. Он разбит на разделы: А — библиография; В — словари, энциклопедии, справочники; С — общие работы, охватывающие широкий круг вопросов; D — исторические и библиографические материалы; Е — руководства по статистическим таблицам; F — таблицы

22

случайных чисел, подчиненных конкретным распределениям; G — таблицы статистических функций; Н — специальные темы, не рассмотренные или кратко изложенные в Справочнике. Ссылки на эти источники в тексте обозначены так: [см. Kendall and Buckland (1971) — В].

1.3.7. ПРИЛОЖЕНИЕ: СТАТИСТИЧЕСКИЕ ТАБЛИЦЫ

Серьезное статистическое исследование предполагает интенсивное использование таблиц [см. список литературы, раздел GJ. Однако во многих случаях читатель обнаружит, что будет достаточным небольшое собрание таблиц в приложении. Это таблицы биномиального, пуассоновского, нормального распределений, распределения Стьюдента и распределения хи-квадрат, 5000 случайных цифр, 500 чисел, распределенных по стандартному нормальному закону, и диаграммы для определения доверительных интервалов параметров биномиального и пуассоновского законов.

1.3.8. ТЕМЫ, НЕ РАССМОТРЕННЫЕ В СПРАВОЧНИКЕ

Идеальная книга по статистике должна содержать сбалансированное описание теории и практики с охватом всех аспектов предмета. Она должна быть понятна читателям и иметь умеренный объем. Издатели считают, что этот идеал не был достигнут: в частности, некоторым темам отведено слишком много места, другим слишком мало, а иные не рассмотрены вовсе. Главный акцент в Справочнике сделан на интерпретацию данных. Практическим деталям сбора данных уделено меньше внимания: краткое введение в планирование сравнительных экспериментов содержится в гл. 9. Для получения более подробной информации о планировании, скажем, выборочных обследований, читатель должен обратиться к списку литературы [см. Arkin (1963); Barnett (1974); Cochran (1963); Deming (1950); Hanson, Hurwitz and Madow (1953); Stuart (1976); Yates (1960) — Н].

Другие темы постигла та же судьба либо потому, что они были сочтены слишком специальными, либо из-за близости их к границам рассматриваемой области, либо потому, что они являются предметом будущих публикаций в серии «Handbook of Applicable Mathematics». Сюда относятся основания и общие принципы нечеткого вывода, приложения математического программирования и методов оптимизации в статистике, анализ специальных типов данных, таких, как направленные данные или экстремальные значения, использование и возможности пакетов статистических программ, статистическое моделирование и метод Монте-Карло, выборочный контроль в промышленности и контроль качества. Работы, посвященные этим проблемам, можно найти в разделе Н списка литературы.

23

1.4. СОГЛАШЕНИЯ И ОБОЗНАЧЕНИЯ

Мы завершаем эту главу замечаниями, касающимися обозначений и других соглашений, которые используются в Справочнике. Некоторые из них стандартны, другие же требуют пояснения.

1.4.1. МАТЕМАТИЧЕСКИЕ СОГЛАШЕНИЯ

Логарифм: если не оговорено другое, log х всегда означает In х, т. е. loge х, натуральный логарифм, логарифм по основанию е.

Символ принадлежности к множеству: € : ^означает, что х — элемент множества (набора класса) Л [см. I, раздел 1.1].

Символ О', мы часто имеем дело со статистиками [см. определение 2.1.1], скажем tn, определенными по выборке объема п, некоторые свойства которой могут быть выражены в виде hn + en, где hn — некоторая функция, а еп — ошибка, которая изчезает с ростом п. Выражение еп = О(1тх), например, означает, что еп имеет тот же порядок, что и л'1, т. е. еп для больших значений п ведет себя, приблизительно как ап' для некоторой константы а. Аналогичный смысл имеет выражение О(п {/2) и т. д. [см. IV, определение 2.3.3].

1.4.2. СТАТИСТИЧЕСКИЕ И ВЕРОЯТНОСТНЫЕ ОБОЗНАЧЕНИЯ И СОКРАЩЕНИЯ

1. Сокращения

ф. р. — (кумулятивная) функция распределения [см. II, разделы 4.3.2, 10.3].

distr ( ) — распределение ( ), как в distr (X) = distr (У), означает, что X и Y имеют общее распределение.

с. с. — степени свободы [см. раздел 2.5.4].

н. о. р. — независимые и одинаково распределенные, как в н. о. р. величины Xi, Х2,..., Хп.

п. р. в. — функция плотности распределения вероятности, называемая также функцией частот. В этой книге мы используем выражение п. р. в. как для дискретных, так и для непрерывных распределений. Те, кто возражает против термина «плотность» для дискретного распределения, может интерпретировать п. р. в. как точечную (point) функцию распределения [см. II, разделы 4.3.1, 10.1].

с. в. — случайная величина, с. п. — случайная переменная [см. II, гл. 4].

~ (тильда) — распределено как. Итак, %~N(^,ct) означает, что распределение X есть нормальное с параметрами ц и ст. Некоторые читатели могут быть настроены против этого обозначения, потому что тильда используется в других разделах математики, например, для обозначения отношения эквивалентности [см. I, раздел 1.3.3], а также асимптотической эквивалентности [см. IV, определение 2.3.2]. Для других же удобство такого обозначения перевешивает возражения.

24

2. Обозначения стандартных распределений

Bernoulli (0) — распределение Бернулли с параметром (вероятностью) успеха 0, т. е. распределение с.в. R с п.р,в.

P(R = г) = 0Г(7—0)’“г, г = 0,1

[см. И, раздел 5.2.1].

Bin (п,0) — распределение с.в. R, для которой

P(R = г) = (”)0Г(7—0)л'г, г = 0,1.п

[см. II, раздел 5.2.2].

Gamma (а,0) — распределение с.в. X с п.р.в.

[х^Лех^]/^Г{а\ х>0.

Здесь а называют параметром масштаба, а 0 — параметром формы [см. II, раздел 11.3.1].

MVN — многомерное нормальное распределение [см. И, раздел 13.4].

N (д,а) — нормальное распределение с ожидаемым значением д и стандартным отклонением а. (Дисперсия есть а2. Некоторые авторы используют поэтому обозначения Normal (д.о3) или N (g,<?).) [См. И, И.4.]

Poisson (0) — распределение с.в. R, для которой

P(R = г) = ев07г!, г = 0,1,...

[см. II, раздел 5.4].

Uniform (a,b) — распределение с.в. X с п.р.в., задаваемой для каждого х как

f(x) =

г 1/(Ь—а), а^х^Ь; -

0 в противном случае

[см. И, раздел 10.7.1].

3. Соглашение об использовании прописных букв для обозначения случайных величин

Мы будем придерживаться следующей системы обозначений: прописные латинские буквы обозначают случайные переменные, а соответствующие строчные латинские буквы — их реализации (наблюденные значения). Итак, мы говорим о совокупности (хь х2,..., хп) наблюдений над с.в. X. В то же время иногда допустимы отклонения от этого правила, например использование F как имени соответствующего распределения.

Строгая приверженность к соглашениям — признак педантичности, и профессиональные статистики не всегда беспокоятся по этому поводу. Однако учащимся и тем, кто еще не стал специалистом, мы рекомендуем их придерживаться.

25

4. Обозначения для моментов и связанных с ними величин

Мы используем символ Е(Х) для обозначения математического ожидания (ожидаемого значения) или с.в. [см. II, гл.8]. Применяются также варианты Е, 8. Наше сокращение для дисперсии X есть var (АЭ; широко используются также символы V(x) и D(X). Для стандартного отклонения X мы используем s. d. (X), для ковариации X и Y — cov(X, У), для коэффициента корреляции между X и Y — согг (X, У), а для асимметрии X — skew (X) [см. II., гл. 9].

5. Нестандартные обозначения: индуцированные случайные величины, статистические копии

Совокупность взаимно независимых наблюдений х2,...,хп случайной величины X (т.е. выборку) можно рассматривать и как совокупность, составленную из наблюдения xt над некоторой случайной величиной Xit наблюдения х2 над некоторой случайной величиной Х2 и т.д., где Xi, Х2.Хп считаются статистическими копиями X. Это

значит, что они независимы и распределены одинаково, так же как распределена случайная величина X:

distr (Xj) = distr (Д')» j ~ 1,2,...и.

Утверждение «х есть реализация ( = наблюденное значение) X» может быть обращено. Итак, «X есть случайная величина, индуцированная х» означает, что выборочное распределение [см. гл. 2} х есть distr (АЭ« Так, статистика ~х = / п (среднее значение выборки),

которая принимает некоторое определенное численное значение для данной выборки, имеет выборочное распределение, которое может быть получено с помощью стандартных процедур из общего распределения Xj, а случайная величина, вероятностное распределение которой совпадает с этим выборочным распределением, является случайной величиной, индуцированной х~. Естественно обозначить ее символом X = i,Xj / п, где Хи X2t...,Xn — статистические копии X.

Говорить о выборочном распределении некоторой статистики, имея в виду вероятностное распределение соответствующей индуцированной случайной величины, столь же педантично по отношению к сказанному выше, сколь и использование различий в обозначениях между случайной величиной X и ее реализацией х\ в обоих случаях целью является ясность изложения.

6. Два смысла обозначения Р(А\К)'. вероятность А при условии К

Один смысл «Р(А\В)у> есть «условная вероятность предложения (события) А при условии, что предложение В истинно» [см. II, раздел 6.5]. Тогда Р(А\В) = Р(А пВ) / Р(В); обе вероятности Р(А) и Р(В) имеют смысл.

Однако мы часто используем Р(А\Н) в смысле «вероятность предложения А, вычисленная в предположениях Н», обычно сокращая это до «вероятность А при Н», где Н является гипотезой. Например, пусть А — предложение Х>х0, а X — нормально распределенная случайная величина N (д,1), где значение ц неизвестно и Н есть гипотеза, что д = 0.

26

Еще одна неоднозначность возникает при использовании выражений P(N = л|0) или ф(п|р), где N— случайная величина, распределение которой зависит от неизвестного параметра 0, a P(N = и|0) означает вероятность получить значение п в качестве наблюдения. Эта выроят-ность зависит от параметра 0. То же относится и к выражениям E(N]0) и т.д. На практике обычно ясно из контекста, какой смысл подразумевается.

7. Номенклатура для табличных значений: процентные точки

В статистической практике часто необходимы таблицы функций различных вероятностных распределений. Для некоторых наиболее употребительных распределений доступны таблицы, которые можно назвать прямыми. Например, в приложении 3 приведена обычная таблица функции Ф(ц), стандартного нормального интеграла (стандартной функции нормального распределения), а в приложении 5 — аналогичная таблица для функции распределения Стьюдента. Однако с целью экономии места таблицы даны в обратной форме. Так, для стандартного нормального распределения таблицы обратной формы содержат значения и в зависимости от Ф (вместо Ф(и) в зависимости от и), т.е. дается значение иа, такое, что 1—Ф(иа) = а, как, например, в приложении 4.

Для случайной величины Z значение такое, что

P(Z>za) = а

называют верхней ХЮа-процентной точкой распределенйя Z; величину такую что

P(Zcr3) = называют нижней процентной точкой; при этом

Ь = Zl~0-

Выражение «процентные точки» без уточнения «верхние» или «нижние» обычно означает «верхние процентные точки».

Процентные точки используются, например, в наиболее доступных таблицах распределения Стьюдента (но не в приведенных в Справочнике), а также в таблицах х2- и P-распределений [см. приложения 6,7].

Нижние процентные точки иногда называют квантилями (фракти-лями). Специальный случай — нижний и верхний квартили, которые являются соответственно 25%-ным и 75%-ным квантилями; медиана же есть 50%-ная точка.

1.5. ЛИТЕРАТУРА ДЛЯ ДАЛЬНЕЙШЕГО ЧТЕНИЯ

Соответствующие справочники и статистические энциклопедии приведены в разделе В списка литературы, учебные пособия — в разделе С, из них особый интерес представляет работа [Barnett (1982)]. Работы по истории вопроса можно найти в разделе D.

27

ДОПОЛНИТЕЛЬНАЯ ЛИТЕРАТУРА

Айвазян С. А., Енюков И. С., Мешалкин Л. Д. Прикладная статистика: Основы моделирования и первичная обработка данных. — М.: Финансы и статистика, 1983. — 471 с.

Айвазян С. А., Енюков И. С., Мешалкин Л. Д. Прикладная статистика: Исследование зависимостей. — М.: Финансы и статистика, 1985. — 487 с.

Айвазян С. А., Бухштабер В. М., Енюков И. С., Мешалкин Л. Д. Прикладная статистика: Классификация и снижение размерности. — М.: Финансы и статистика, 1988. — 607 с.

Бикел П., Доксам К. Математическая статистика. Вып. 1 / Пер. с англ. — М.: Финансы и статистика, 1983. — 278 с.

Бикел П., Доксам К. Математическая статистика. Вып. 2 / Пер. с англ. — М.: Финансы и статистика, 1983. — 254 с.

Джонсон Н., Лион Ф. Статистика и планирование эксперимента в технике и науке: Методы обработки данных / Пер. с англ.; Под ред. Э. К. Лецкого. —М.: Мир, 1980. — 510 с.

Джонсон Н., Лион Ф. Статистика и планирование эксперимента в технике и науке: Методы планирования эксперимента / Пер. с англ.; Под ред. Э. К. Лецкого, Е. В. Марковой. — М.: Мир, 1981. — 516 с.

Закс Л. Статистическое оценивание / Пер. с нем.; Под ред. Ю. П. Адлера, В. Г. Горского. — М.: Статистика, 1976. — 598 с.

Кендалл М., Стьюарт А. Теория распределений / Пер. с англ.; Под ред. А. Н. Колмогорова. — М.: Наука, 1966. — 587 с.

Кендалл М.,Стьюарт А. Статистические выводы и связи / Пер. с англ.; Под ред. А. Н. Колмогорова. — М.: Наука, 1973. — 899 с.

Кендалл М.,Стьюарт А. Многомерный статистический анализ и временные ряды / Пер. с англ.; Под ред. А. Н. Колмогорова, Ю. В. Прохорова. — М.: Наука, 1976. — 736 с.

Химмельблау Д. Анализ процессов статистическими методами / Пер. с англ.; Под ред. В. Г. Горского. — М.: Мир, 1973. — 957 с.

Глава 2

ВЫБОРОЧНЫЕ РАСПРЕДЕЛЕНИЯ

2.1. МОМЕНТЫ И ДРУГИЕ СТАТИСТИКИ

2.1.1. СТАТИСТИКА

Как уже объяснялось в гл. 1, если мы стремимся описать изменчивые и неопределенные черты природы, то разумно это сделать, пользуясь понятиями случайной величины и ее распределений вероятностей (см. II, гл. 4). При этом обычно постулируется, что эти распределения должны принадлежать к определенным семействам, предполагаемым в явном виде или подразумеваемым. Тогда одной из целей статистического исследования будет выделение того члена заданного семейства рассматриваемого распределения, с которым мы имеем дело, исключение (по крайней мере, условное) некоторых возможных членов в семействе или отрицание либо подтверждение принадлежности к постулированному семейству в целом. Эти цели могут быть достигнуты в результате проведения соответствующего анализа доступных данных. Оказывается, что основную роль в анализе играют комбинации величин, получаемых из имеющихся данных, каждая из которых называется статистикой. Эти комбинации, заслуживающие отдельного рассмотрения, зависят от природы распределений вероятностей, включенных в анализ, а также от характера выводов, которые пытаются получить.

Пример 2.1.1. Выборочная проверка. Рассмотрим набор (группу или партию) более или менее схожих предметов, состоящих из отдельных единиц, которые, однако, различаются по определенному признаку, измеряемому или наблюдаемому. Например, это могли бы быть обработанные бруски длиной номинально 50 мм. Действительная же длина их несколько меняется вследствие флуктуаций в процессе производства. Желательно оценить долю брусков, длина которых колеблется в заданном диапазоне, например между 49 и 51 мм. Такие бруски будем называть годными, в то время как остальные будут называться дефектными. По практическим соображениям оказывается неприемлемым проверить все бруски в партии. Вместо этого можно проверить выборку из брусков, определив заранее ее объем, например 100 штук. При этом потенциально доступная информация — размещение меток

29

«годный», «дефектный» на каждом из 100 проверенных брусков. Если бы выборка формировалась случайно (и были бы предприняты обычные предосторожности, чтобы гарантировать ее случайность), т. е. так, чтобы у каждого из различимых (неупорядоченных) подмножеств по 100 брусков были бы одинаковые шансы оказаться выбранным, то полной информации об этих 100 метках на брусках не потребовалось бы. При последующем анализе понадобилось бы только общее число дефектных единиц в выборке (например, четыре).

В этом примере статистикой является просто общее число дефектных единиц в выборке.

Для выборки объема s, извлеченной из партии объема Ь, содержащей d дефектных единиц (где d неизвестно), число дефектных единиц будет случайной величиной (скажем, 7?). Вероятность того, что в данной выборке окажется определенное число (например, г) дефектных единиц, равняется

P^=r;=(?;(fcr/;/fJ;r=O,l,...,min (5, d). (2.1.1)

Это элемент семейства гипергеометрических распределений [см. И, раздел 5.3]. Неизвестным параметром, с помощью которого идентифицируют члены семейства, является переменная d, относящаяся к партии в целом. Выводы относительно значения d должны основываться на статистике (в нашем примере равной четырем), т. е. на полном числе дефектных единиц в выборке [см. пример 2.1.1].

Пример 2.1.2 (продолжение). Использование упрощенных аппроксимирующих семейств распределений. Если бы в примере 2.1.1 объем партии был гораздо больше, чем объем выборки (например, Ь~ 10000, 5=100), то можно было бы с небольшой погрешностью заменить гипергеометрическое распределение (2.1.1) биномиальным (см. И, раздел 5.2.2):

P(R=r)=fi)pr(\-pf~r, г=0,1 s, p~d/b. (2.1.2) Полное число дефектных единиц в выборке по-прежнему оставалось бы подходящей статистикой.

Пример 2.1.3 (продолжение). Введенное в примере 2.1.1 семейство распределений предопределяется процедурой формирования выборки. Теперь предположим, что вместо того, чтобы пытаться оценить долю — т (49,51), скажем, брусков, длина которых х лежат в заданном интервале [х49Сл'С51), надо для всех пар значений и и v(u<v) оценить долю x(u,v) тех брусков, длина которых х принадлежит интервалу Эта задача эквивалентна следующей: будем считать измеренную длину х определенного бруска реализацией непрерывной случайной величины X [см. II, раздел 10.1] и оценим распределение вероятностей X. Это в свою очередь можно было бы интерпретировать следующим образом: постулируем для X нормальное распределение с математическим ожиданием g и стандартным отклонением о [см. II, раздел 11.4] и оценим значения параметров распределения д .и а. [Естественно подумать, что это несостоятельный постулат, так как в прин-30

ципе можно получить сколь угодно большие наблюдаемые значения |Af|, если величина X нормально распределена. В то же время длина наших брусков не может быть меньше нуля и практически не будет больше, чем например, 60 мм. Однако фактически предположение нормальности может оказаться вполне разумным, если стандартное отклонение будет малым [см. II, разделы 9.2 и 11.4.3], так как тогда становится пренебрежимо малой вероятность очень больших отклонений от среднего.] В этом случае подходящими статистиками были бы ухг и ^хгг [см. раздел 6.4.1] (при условии, что заданы длины хх,х2.хп

j 1

брусков в выборке объема «ил существенно меньше, чем объем партии).

Пример 2.1.4. Нестатическая ситуация. В примерах 2.1.1, 2.1.2 и 2.1.3 мы имели дело с выборками, взятыми из фиксированного распределения. Такие случаи можно назвать статическими. Рассмотрим нестатическую ситуацию. На пружине, закрепленной с одного конца, подвешен определенный груз х;. На результат измерения длины пружины у, влияют ошибки измерения. Процедура повторяется для / = 1»2.Веса хх,х2,..,хк считаются точно известными числами. Пе-

ременные такого типа часто называют неслучайными переменными. Соответствующие длины пружины содержат ошибки. Удобная модель: для каждого i будем рассматривать у, как реализацию нормально распределенной случайной переменной с математическим ожиданием [см. II, раздел 8.1] £'(У/) = а+ (jXj (закон Гука) и дисперсией [см. II, раздел 9.1] ог (одинаковой для всех z). Цель эксперимента состоит в том, чтобы оценить модуль упругости /3. Оказывается, что соответствующими этому случаю статистиками будут и ууху-

[см. пример 4.5.3]. Они представляют собой комбинации наблюдаемых значений yj случайных переменных и связанных с ними неслучайных переменных x-t.

Теперь суммируем результаты анализа рассмотренных примеров в виде следующего определения.

Определение 2.1.1. Статистика. Пусть ух,у2 ук обозначает множество наблюдаемых значений случайных ’ переменных, а Xj^r2...хт — множество (известных) значений связанных с ними не-

случайных переменных. Статистикой называется любая функция этих переменных, например ,h(ylt...yk\ xp...,xw), количественное значение которой может быть рассчитано, как только будут указаны выборочные значения уг и величины связанных с ними переменных xs.

В любой процедуре вывода могут быть использованы только статистики. Например, согласно теории оценивания надо указать, каким членом заданного семейства распределений порождена выборка. При этом требуется дать численное значение (оценку) каждому параметру, который содержится в математических формулах, определяющих семейство

31

[см. гл. 3]. Каждое такое численное значение должно быть статистикой. Практические правила оценивания сводятся к выбору статистик, наиболее подходящих для этой цели.

Статистики, которые строятся в теории оценивания и в теории проверки статистических гипотез, часто оказываются комбинациями простой системы статистик, известных как выборочные моменты и являющихся выборочными аналогами моментов генеральной совокупности.

2.1.2. МОМЕНТЫ

а) Моменты генеральной совокупности. Важным множеством постоянных величин, связанных со случайной переменной и ее распределением вероятностей, оказывается множество моментов генеральной совокупности [см. II, раздел 9.11]. Моментом порядка г(г=Ъ2,...) случайной переменной X называют величину

^Е(ХГ). (2.1.3)

Моментом первого порядка ц! будет просто математическое ожидание X, часто обозначаемое символом д:

д=д[=Е(Л). (2.1.4)

К моментам относят также и центральные моменты

р=Е(Х—цУ г=1,2,... (2.1.5)

Центральный момент первого порядка тождественно равен нулю. Центральным моментом второго порядка является дисперсия (мера изменчивости). Момент третьего порядка связан с асимметрией (мерой асимметрии). Коэффициент асимметрии X определен как

skew (X)=дз/дг72 (2.1.6)

Центральный момент четвертого порядка д4 связан с кривизной п.р.в. вблизи ее максимума. Для центральных моментов более высокого порядка нет непосредственной интерпретации.

Возможны очевидные обобщения на случай многомерных распределений. Например, для генеральной совокупности, каждый из членов которой обладает двумя интересующими нас признаками, такими, как рост и вес, обратимся к паре случайных переменных, например (А",У), реализации которых (xit уО,(хг, уг),... представляют пары (рост, вес) членов совокупности. Вероятностное поведение X и Y описывается их совместным распределением вероятностей.

Двумерные моменты (или моменты произведений) этого распределения задаются величинами

I^EfX'Y5), V=l,2.......

а центральные моменты определяются как дгд=£(<х-£/(У-д/}, t=E(X), n=E(Y). (2Л,7)

32

Наиболее важным среди этих смешанных моментов является ковариация, определяемая как

covfc>9=>41 j (Х—£)(у—ц)).

Ее нормированная версия

Q(X,Y^^/axaY (2.1.8)

называется коэффициентом корреляции corr(X,Y), величина которого при подходящих обстоятельствах будет мерой связи между X и Y. Здесь = var<A7, = var(Y).

б) Моменты выборки*. Выборочными аналогами теоретических моментов (моментов генеральной совокупности) являются моменты выборки. Для выборки (хх^сг,...х„) момент порядка г определяется как

т'= L х^/п, г=1,2,... . (2.1.9)

r j=i 1

Если выборка задается в виде таблицы частот, а именно, если Xi,x2,...,хк — список возможных различных наблюдаемых значений X, а — частоты, с которыми они появляются в выборке, то

шг'= £4Л7/Л> где k

п- Е fr

есть объем выборки.

Аналогично получаем центральные моменты выборки, известные также как моменты выборки относительно среднего, задаваемые в виде

mr= Е (Xj—xf/n, r=l, 2,..., (2.1.10)

y=i j

где

x =m\

есть среднее по выборке. Соответствующее выражение для таблицы частот имеет вид

т = I fi(x.—xf/n, r=l, 2,... . (2.1.11)

r j=i J J

Соотношение между моментами выборки относительно среднего и относительно начала отсчета. Моменты выборки тг относительно среднего связаны с соответствующими моментами т'г относительно начальной точки следующими соотношениями:

т2=т\—х2, т3 =т$—Зт& +2х3,

(2.1.12)

и т. д.

т4=/и4/—imjX + 6трс2—Зх4.

а

• В советской литературе часто употребляется термин «выборочные моменты» (см. также примечание на с. 39). — Примеч. ред.

33

Моменты выборки тр т'г порядка г являются оценками соответствующих моментов генеральной совокупности цг, ц,, хотя и не обязательно наилучшими.

В пункте в) обсуждается второй момент выборки.

в) Дисперсия выборки и стандартное отклонение выборки. Момент второго порядка выборки относительно среднего представляет собой один из вариантов дисперсии выборки. Однако более часто последняя определяется как

Л _

^=птг/(п-1)= Е (Xj—х)2/(п-\) (2.1.13)

или, эквивалентно, в случае таблицы частот

$*= T.fj(Xj—х)2/(п-1А п- Efj.

Положительное значение квадратного корня из этого выражения 5 называют стандартным отклонением выборки из наблюдаемой переменной.

Идея взять делитель в виде п—1 вместо п подкрепляется одним или несколькими из следующих аргументов:

1) смещение: s2 — несмещенная оценка дисперсии о2 генеральной совокупности; это означает, что среднее большого числа п выборочных значений приближается к о2, когда п становится сколь угодно большим [см. раздел 3.3.2]. В противоположность этому следует сказать, что s не является несмещенной оценкой а [см. раздел 2.3.5]*;

2) имеет смысл при л=1: когда п равно единице, s2 не определено. Именно это требуется от выборочной оценки ст2, так как при объеме выборки, равном единице, нет информации относительно изменчивости (разброса). Однако значение тг обращается в нуль. Это не слишком хорошая оценка для ст2;

3) «не раскачивайте лодку»: в стандартных процедурах оценивания и проверки гипотез и в соответствующих таблицах применяется делитель п—1 [см., например, раздел 2.5.5]; „ _

4) степени свободы: сумму квадратов Е (xj—х)г можно выразить в виде суммы квадратов п — 1 алгебраическилнезависимых переменных: другими словами, квадратическая форма Е (хг—х/ имеет п — 1 степеней свободы (или ранг порядка п — 1). В результате становится и логически привлекательно, и удобно по алгебраическим мотивам делить на (л—1).

г) Двумерные выборки. В выборке (хх,ух),(хг,уг), ...,(хп,у„), из двумерной генеральной совокупности, где хг обозначает, например, рост, а уг — вес г-го индивида в выборке, выборочная ковариация определяется как

* Несмещенность s2 означает, что Es2 = a (при этом Es^a2). Указанное авторами свойство при л-»00 обычно называют состоятельностью. —Примеч. ред.

34

тхл = х)(уг—у )/n = { nxу ) /и, (2.1.14)

где x ~'Exr/n и у ~Еуг/п. В случае таблицы частот это выражение заменяется на t

/и1Д = Lfr(xr—x)(yr—y)/n.

По причинам, аналогичным тем, которые перечислены применительно к выборочной дисперсии в пункте 1), более принята оценка ковариации /*1 л генеральной совокупности не в виде /им, а в виде

М = ^(Xi—x)(y,—у)/(п— Ц (2.1.15)

В общем случае смешанный момент порядка г, s для двумерной выборки записывается в виде

m^txr.ys./n, г,5= 1,2 (2.1.16)

а соответствующие центральные моменты в виде

тГг5 =^(х{-х)г(У1-у?/п. (2.1.17)

В особом случае, когда 5=0, г=0, оказывается, что

mr,o = i(Xf—xf/n, г — 1,2,...;

п _ (2.1.18)

mQJS ^(у~yf/n, 5=1,2,... .

Эти величины являются маргинальными центральными моментами порядка г для значений х и маргинальными центральными моментами порядка 5 для значений у. Для таблицы частот необходимо изменить эти формулы очевидным образом [ср. (2.1.10), (2.1.11)].

Коэффициент корреляции. Нормированная версия

r(x,y) =miti/y/(mi0m0l) (2.1.19)

выборочной ковариации называется выборочным коэффициентом корреляции (моментным), или (иногда) коэффициентом корреляции К. Пирсона. Она является оценкой коэффициента корреляции $(х,у) (2.1.8) генеральной совокупности. Отметим, что выражение

r(x,y) = Cj , /s(x)s(y), где 52<х> — выборочная дисперсия (2.1.13) значений х, а &(у) — выборочная дисперсия значений у, эквивалентно выражению (2.1.19).

2.2. ВЫБОРОЧНЫЕ РАСПРЕДЕЛЕНИЯ: ОПРЕДЕЛЕНИЯ И ПРИМЕРЫ

Выбрав определенную статистику, такую, как среднее выборки (среднее значение наблюдений), и отметив ее значение, мы вынуждены признать, что при повторении процедуры выборки численное значение

35

этой статистики во второй выборке будет, вероятно, отличаться от ее значения в первой выборке. Последовательность таких повторений породила бы последовательность числовых значений статистики; одни значения встречались бы чаще, другие — реже. Таким образом, мы можем представить совокупность значений вместе с распределением вероятностей среди них. Это и есть выборочное распределение статистики.

В примерах 2.1.1 и 2.1.2 рассматривалась статистика г — количество дефектных единиц в выборке. В примере 2.1.2 она трактовалась как реализация (т.е. наблюдение) случайной переменной R [см. II, гл. 4], которая имеет распределение Вт&д) [см. II, раздел 5.2.2]. В этом случае число обследованных брусков s является числом «испытаний», как это понимается для биномиального распределения, а р — неизвестной долей дефектных изделий в партии.

Статистика г является реализацией случайной величины R. Выборочное распределение статистики г оказывается распределением вероятностей (2.1.2) [см. II, раздел 4.3] соответствующей случайной переменной R. В примере 2.1.3 рассматривались статистики и Ех/, при этом хг были реализациями случайной переменной X, распределенной N(/x,a) [см. II, раздел 11.4].

С точки зрения обозначений удобно рассматривать xi как реализацию случайной переменной Jfpx2 — как реализацию случайной переменной Х2,... и, наконец, хп — как реализацию Хп, где случайные переменные XvX2,...,Xn — н.о.р. (т.е. взаимно независимые [см. II, раздел 4.4] и одинаково распределенные переменные). При этом их общее распределение — это распределение исходной случайной переменной X. Взаимная независимость [см. II, определение 4.4.1] наблюдаемых событий Ar=xp Х~х2,..., обеспеченная процедурой выборки, отражается в предположении взаимной независимости случайных переменных Хп а тот факт, что все наблюдения хг взяты из одного и того же распределения, отражается в приписывании всем Хг распределения X. О переменной Хг можно говорить как о статистической копии X [см. определение 2.2.1].

Определение 2.2.1. Статистические копии, индуцированные случайные переменные, случайная выборка. Говорят, что случайные переменные XVX2,... будут статистическими копиями заданной случайной переменной X, если Хг взаимно независимы и одинаково распределены, причем их общее распределение совпадает с распределением X. Множество независимых наблюдений (xY,x2,...,xk) переменной X называется случайной выборкой. По соображениям удобства можно считать xt наблюдением Xlt х2 — наблюдением Х2 и т. д. Эти случайные переменные XitX2,... индуцируются (порождаются) наблюдениями хрх2,... Аналогично статистика y=h(xitx2,...,xk) порождает случайную переменную Y=h(XltX2,...,Xk). (Определение, случайной выборки из конечной совокупности можно найти, например, в [II, раздел 5.3].)

36

В примере 2.1.3, таким образом, статистики i.xr и могут рассматриваться как реализации индуцированных случайных переменных соответственно ЁАГГ и ЁА^, где хрх2,...хл — статистические копии х. Теперь случайная переменная становится суммой п взаимно независимых переменных N(p,a) и поэтому сама оказывается распределенной нормально с математическим ожиданием ц и стандартным отклонением а/4п [см. раздел 2.5.3, а)]. Это распределение NQi,ff/Vn) будет выборочным распределением статистики t,xr. Подобным об-разом выборочным распределением статистики Ех* является распределение индуцированной случайной переменной ЕА^.

В примере 2.1.4 имелось к взаимно независимых случайных переменных Ур У2,..., Yk, распределения которых уже не были одинаковыми. Вместе с наблюдаемыми значениями уг переменной Уг у нас были неслучайные переменные хг, известные точно. Статистика t>xryr рассматривается как реализация случайной переменной ЁхгУг, являющейся взвешенной суммой независимых случайных переменных ........

Выборочным распределением статистики Ёх.у_ будет распределе-1 * ние вероятностей индуцированной случайной переменной ЕхгУг

В этом примере оказывается, что Yr — независимые нормально распределенные случайные переменные с параметрами E(Yr) = а + (5хг и v&r(Yr)- о2, г- 1,2,..., к. Отсуда вытекает [см. раздел 2.5.3] нормальность выборочного распределения переменной Ехгуг с ожиданием аЕхг + 0Ех* и дисперсией а2Ехг2.

В свете этих примеров можно дать формальное определение выборочного распределения.

Определение 2.2.2. Выборочное распределение статистики. Пусть УрУр..«»Ул представляют собой собрание данных, в которых yj для каждого j может рассматриваться как реализация случайной переменной Yj. Пусть xpx2,...,xm — множество неслучайных переменных, значения которых известны (сюда может входить, например, объем выборки). Пусть рассматриваемой статистикой будет

Л ,У2,. •. ,УЛ, Xj ,Х2,... tXffJ •

Выборочным распределением этой статистики называют распределение вероятностей индуцированной случайной переменной

й (^Ур У2, • • •, Ул, хрх2,... ,x^).

В этих выражениях уг могут быть скалярными или векторными величинами [см. I, разделы 5.1, 5.2]. В последнем случае Уг — векторные случайные переменные [см.П, раздел 13.3.1]. Аналогично переменные хс могут быть скалярными или векторными. Статистика Л

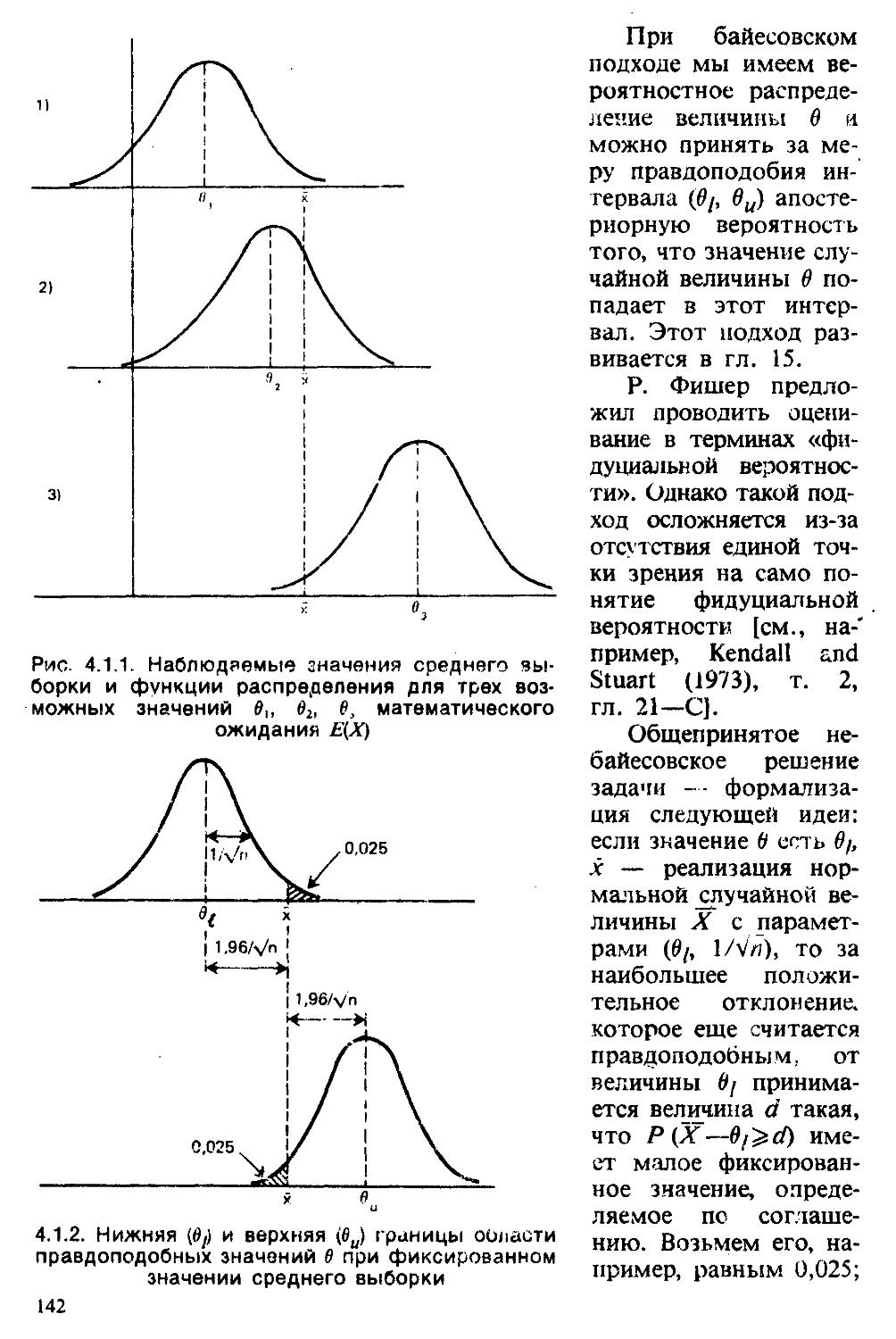

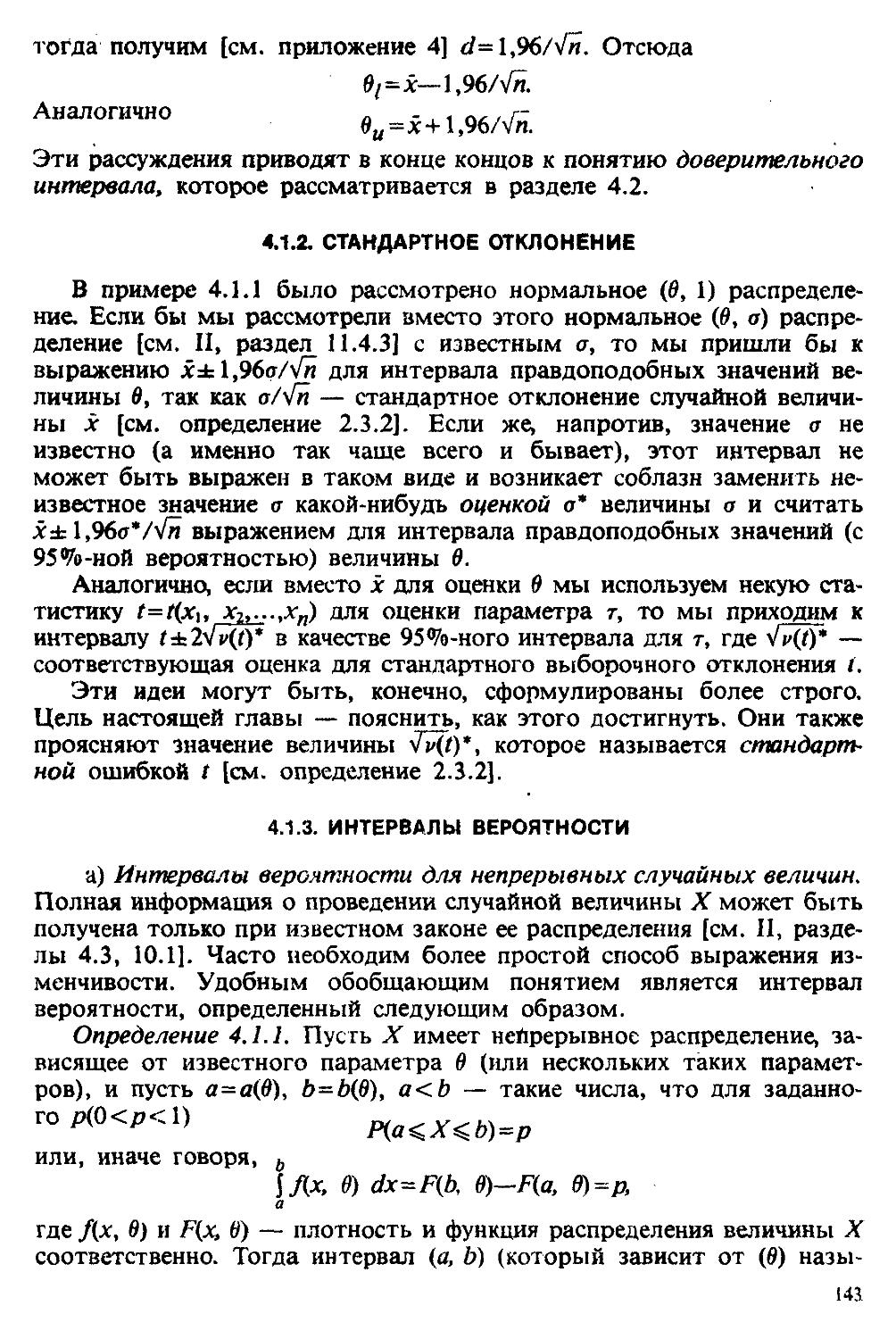

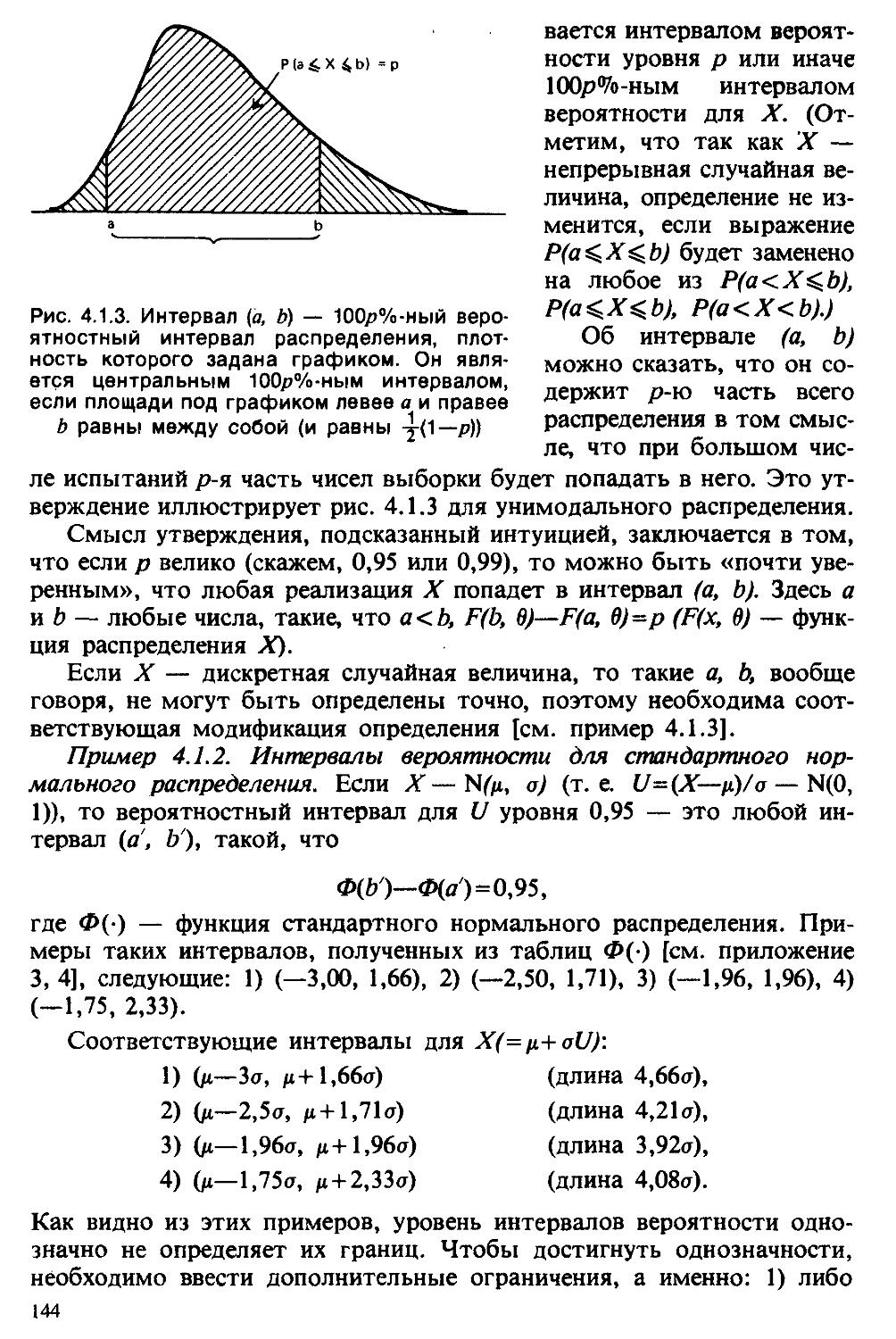

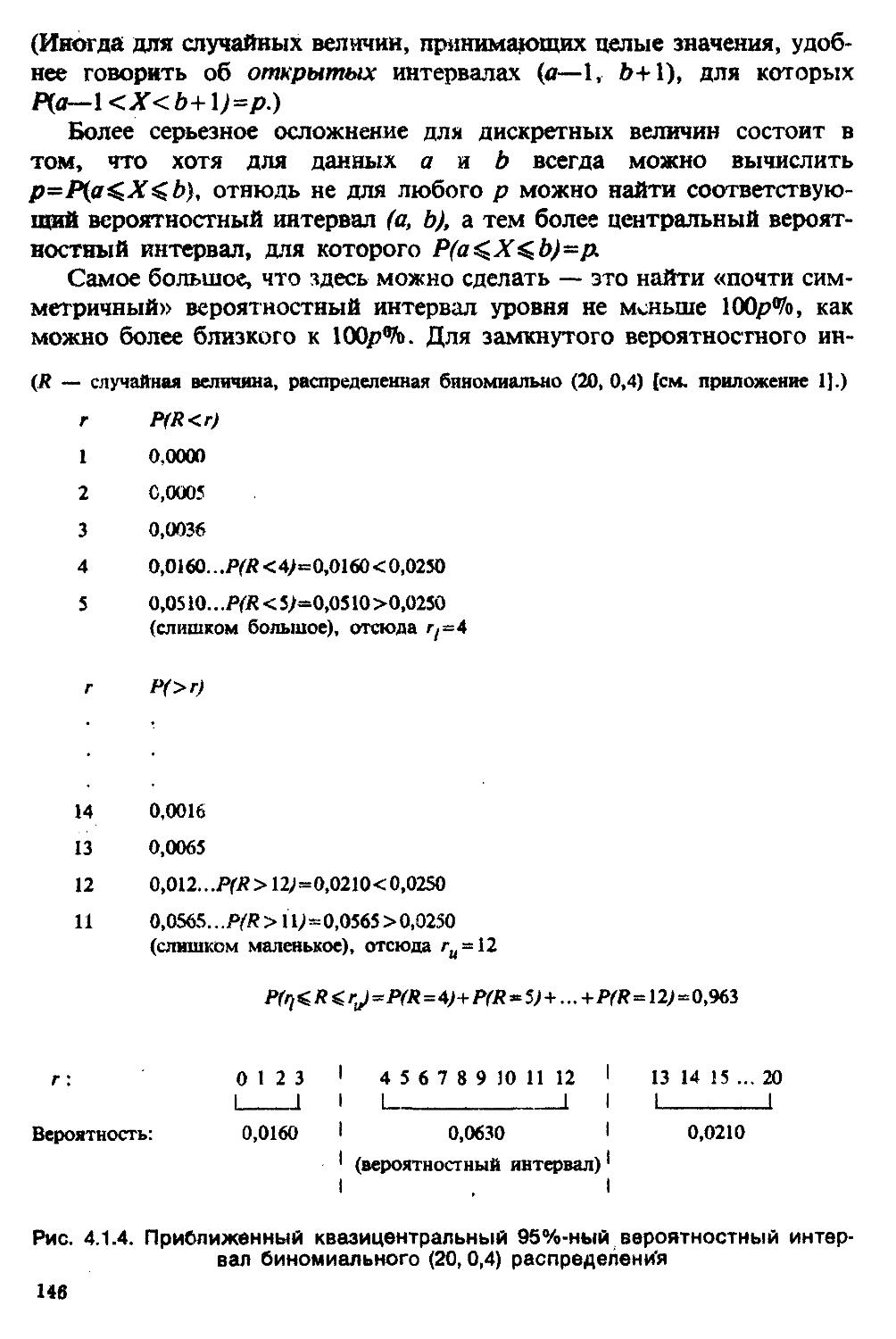

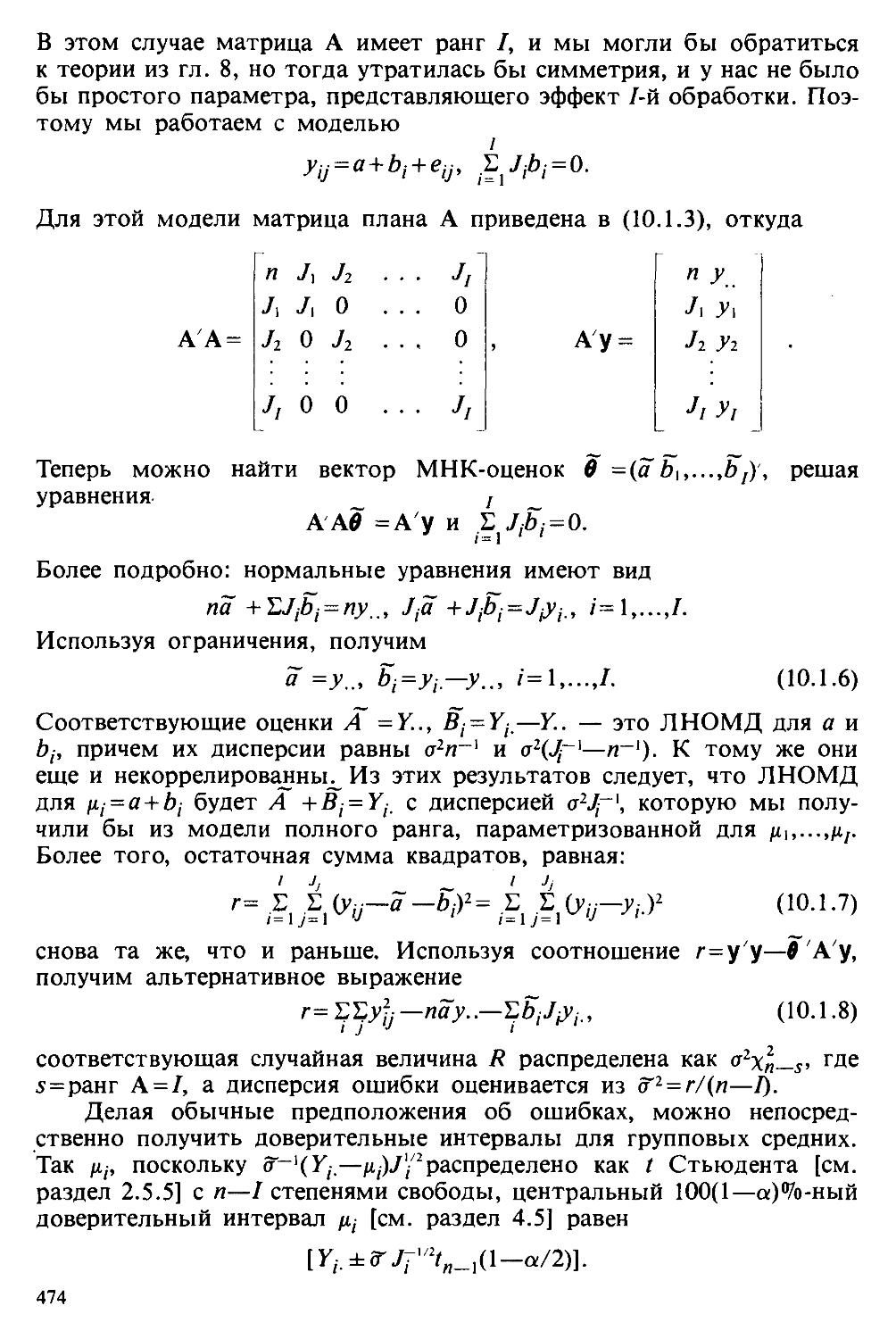

37