Автор: Сетубал Ж. Мейданис Ж.

Теги: материальные основы жизни биохимия молекулярная биология биофизика виды компьютеров биология вычислительная молекулярная биология биоинформатика и молекулярная биология

ISBN: 978-5-93972-623-8

Год: 2007

Ж. Сетубал, Ж. Мейданис

^/«sgw/F

СЕРИЯ «БИОИНФОРМАТИКА И МОЛЕКУЛЯРНАЯ БИОЛОГИЯ»

Вышли в свет:

Дурбин Р., Эдди Ш.. Крог А., Митчисон Г.

Анализ биологических последовательностей

Игнасимуту С.

Основы биоинформагики

Эвери Дж.

Теория информации и эволюция

Готовится к публикации:

Бородовский М., Екишева С.

Анализ биологических последовательностей.

Задачи и решения

СЕРИЯ «БИОИНФОРМАТИКА И МОЛЕКУЛЯРНАЯ БИОЛОГИЯ»

Главные редакторы:

Садовничий В. А. (МГУ им. М. В. Ломоносова) Скулачев В. П. (факультет биоинженерии и биоинформатики МГУ им. М. В. Ломоносова)

Редакционная коллегия:

Богданов А. А. (Институт физико-химической биологии им. А. Н. Белозерского МГУ)

Гельфанд М.С. (Институт проблем передачи информации им. А. А. Харкевича РАН)

Есипова Н. Г. (Институт молекулярной биологии им. В. А. Энгельгардта РАН)

Кирпичников М.11, (биологический факультет МГУ им. М. В. Ломоносова) Колчанов Н. А. (Институт цитологии и генетики СО РАН) Миронов А. А. (факультет биоинженерии и биоинформатики МГУ им. М. В. Ломоносова)

Ризниченко Г. Ю. (биологический факультет МГУ им. М. В. Ломоносова) Ройтбсрг М. А. (Институт математических проблем биологии РАН) Рубин А. Б. (биологический факультет МГУ им. М. В. Ломоносова) Финкельштейн А. В. (Институт белка ПНЦ РАН)

Шайтан К. В. (биологический факультет МГУ им. М. В. Ломоносова)

Жуан Сетубал и Жуан Меиданис

ВВЕДЕНИЕ В ВЫЧИСЛИТЕЛЬНУЮ МОЛЕКУЛЯРНУЮ БИОЛОГИЮ

Перевод с англ. А. А. Чумичкина Под ред д. б. н., проф. А. А. Миронова

Москва ♦ Ижевск

2007

INTRODUCTION TO COMPUTATIONAL MOLECULAR BIOLOGY

JOAO SETUBAL and ЮАО MEIDANIS

University of Campinas, Brazil

PWS PUBLISHING COMPANY

I(T)P

An International Thomson Publishing Company

BOSTON • ALBANY • BONN • CINCINNATI • DETROIT • LONDON MELBOURNE • MEXICO CITY • NEW YORK • PACIFIC GROVE • PARIS SAN FRANCISCO • SINGAPORE • TOKYO • TORONTO

УДК 577:004.383

ББК 28.070с51

С334

И нтернет-магазин

http://shop.rcd.ru

• физика

• математика

•биология

• нефтегазовые гехноло!ин

Сезубал Ж., Мейлаиис Ж.

Введение в вычислительную молекулярную биологию. — Москва Ижевск: НИЦ «Регулярная и хаотическая динамика», Институт компьютерных исследований, 2007. — 420 с.

Настоящая книга представляет собой введение в вычислительную молекулярную биологию, описывает наиболее типичные ее задачи и предлагает эффективные алгоритмы их решения. Книга начинается с обзора фундаментальных понятий молекулярной биологии (в том числе структура и функции белков и нуклеиновых кислот, механизмы молекулярной генетики), далее вводятся важнейшие математические объекты, такие как графы и строки, и приводятся общие сведения об алгоритмах. Все это подготавливает почву для понимания дальнейших разделов книги-сравнение последовательностей (и поиск в базе данных), сборка фратментов ДНК, составление физических карт ДНК, филогенетические деревья, перестройка генов, предсказание структуры макромолекулы и вычисления с помощью ДНК. Каждый из этих разделов содержит обсуждение биологических предпосылок, определения ключевых терминов, полное описание применяемых математических или компьютерных моделей, а также примеры реализации алгоритмов.

Книга предназначена для программистов, математиков и биологов, стремящихся расширить свои познания в этой новой захватывающей области науки, где еще так много нерешенных задач.

ISBN 978-5-93972-623-8 ББК 28.070с51

© 1997 by Brooks/Cole Publishing Company,

a division of International Thomson Publishing Inc.

© Перевод на русский язык:

НИЦ «Регулярная и хаотическая динамика», 2007.

http://shop.rcd.ru

http://ics.org.ru

Оглавление

ПРЕДИСЛОВИЕ . . 12

Глава 1 ОСНОВНЫЕ ПОНЯТИЯ МОЛЕКУЛЯРНОЙ БИОЛО-

ГИИ ............................ 20

1.1. ЖИЗНЬ................................. 20

1.2. БЕЛКИ................................. 21

1.3. НУКЛЕИНОВЫЕ КИСЛОТЫ 26

1.3.1. ДНК............................. 26

1.3.2. РНК............................. 30

14 МЕХАНИЗМЫ МОЛЕКУЛЯРНОЙ ГЕНЕТИКИ ... 30

1.4.1. ГЕНЫ И ГЕНЕТИЧЕСКИЙ КОД ... 30

1.4.2. ТРАНСКРИПЦИЯ, ТРАНСЛЯЦИЯ И СИНТЕЗ БЕЛКА 32

1.4.3. ИЗБЫТОЧНАЯ ДНК И РАМКИ СЧИТЫВАНИЯ ... 36

1.4.4. ХРОМОСОМЫ ...................... 37

1.4.5. ПОДОБЕН ЛИ ГЕНОМ КОМПЬЮТЕРНОЙ ПРОГРАММЕ? ............................... 39

1 5. МЕТОДЫ ИЗУЧЕНИЯ ГЕНОМА................ 40

1.5.1. КАРТЫ И ПОСЛЕДОВАТЕЛЬНОСТИ 40

1.5.2. СПЕЦИАЛЬНЫЕ МЕТОДЫ ............. 43

1.6. ПРОЕКТ «ГЕНОМ ЧЕЛОВЕКА»............... 49

1.7. БАНКИ ПОСЛЕДОВАТЕЛЬНОСТЕЙ НУКЛЕОТИДОВ 51

УПРАЖНЕНИЯ . 59

БИБЛИОГРАФИЧЕСКИЕ ПРИМЕЧАНИЯ 59

Глава 2. СТРОКИ, ГРАФЫ И АЛГОРИТМЫ............61

2.1. СТРОКИ.............................. 61

2.2. ГРАФЫ..................................63

2 3 АЛГОРИТМЫ ..............................68

УПРАЖНЕНИЯ................................ 76

БИБЛИОГРАФИЧЕСКИЕ ПРИМЕЧАНИЯ............... 78

8

Оглавление

Глава 3. СРАВНЕНИЕ ПОСЛЕДОВАТЕЛЬНОСТЕЙ И ПОИСК В

БАЗАХ ДАННЫХ............................... 80

3.1. БИОЛОГИЧЕСКИЕ ОСНОВЫ СРАВНЕНИЯ ПОСЛЕДОВАТЕЛЬНОСТЕЙ ................................ 80

3.2. СРАВНЕНИЕ ДВУХ ПОСЛЕДОВАТЕЛЬНОСТЕЙ ... 83

3.2.1. ГЛОБАЛЬНОЕ СРАВНЕНИЕ - ОСНОВНОЙ АЛГОРИТМ ................................... 83

3.2.2. ЛОКАЛЬНОЕ СРАВНЕНИЕ..............91

3.2.3. ПОЛУГЛОБАЛЬНОЕ СРАВНЕНИЕ.........92

3.3. РАСШИРЕНИЯ К ОСНОВНЫМ АЛГОРИТМАМ...... 95

3.3.1. ЭКОНОМИЯ ПРОСТРАНСТВА........... 96

3.3.2. ОБЩИЕ ФУНКЦИИ ШТРАФОВ ЗА ПРОПУСКИ ... 100

3.3.3. ЛИНЕЙНЫЕ ФУНКЦИИ ШТРАФОВ ЗА ПРОПУСКИ 104

3.3.4. СРАВНЕНИЕ ПОДОБНЫХ ПОСЛЕДОВАТЕЛЬНОСТЕЙ ...................................107

3.4. МНОЖЕСТВЕННОЕ СРАВНЕНИЕ ПОСЛЕДОВАТЕЛЬНОСТЕЙ ..................................... III

3.4.1. МЕРА ПАРНЫХ СУММ................112

3.4.2. ВЫРАВНИВАНИЕ ЗВЕЗДЫ............ 122

3.4.3. ВЫРАВНИВАНИЕ ПО ДЕРЕВУ .... ... 125

3.5. ПОИСК В БАЗАХ ДАННЫХ .127

3.5.1. МАТРИЦЫ ПТМ .................. 128

3.5.2. BLAST...........................133

3.5.3. FAST............................138

3.6. РАССТОЯНИЕ, СОПОСТАВЛЕНИЕ СТРОК И ТОЧНОЕ СРАВНЕНИЕ ПОСЛЕДОВАТЕЛЬНОСТЕЙ..............141

3.6.1. * ПОДОБИЕ И РАССТОЯНИЕ......... 142

3.6.2. ВЫБОР ПАРАМЕТРОВ ПРИ СРАВНЕНИИ ПОСЛЕДОВАТЕЛЬНОСТЕЙ .........................151

3.6.3. СОПОСТАВЛЕНИЕ СТРОК И ТОЧНОЕ СРАВНЕНИЕ ПОСЛЕДОВАТЕЛЬНОСТЕЙ.................155

РЕЗЮМЕ.....................................157

УПРАЖНЕНИЯ ................................158

БИБЛИОГРАФИЧЕСКИЕ ПРИМЕЧАНИЯ ..............161

ГЛАВА 4. СБОРКА ФРАГМЕНТОВ ДНК...............165

4.1. БИОЛОГИЧЕСКИЙ АППАРАТ СЕКВЕНИРОВАНИЯ .165

4.1.1. ИДЕАЛЬНЫЙ СЛУЧАЙ................167

4.1.2. ТРУДНОСТИ.......................168

Оглавление

9

4.1.3. АЛЬТЕРНАТИВНЫЕ МЕТОДЫ СЕКВЕНИРОВАНИЯ ДНК . ...............176

4.2. МОДЕЛИ . ............ 178

4.2.1. КРАТЧАЙШАЯ ОБЩАЯ НАДСТРОКА........178

4.2.2. ВОССТАНОВЛЕНИЕ 180

4.2.3. МУЛЬТИКОНТИГИ ....................182

4.3. * АЛГОРИТМЫ.............................184

4.3.1. ПРЕДСТАВЛЕНИЕ ПЕРЕКРЫТИЙ..........185

4.3.2. ПУТИ, ПОРОЖДАЮЩИЕ НАДСТРОКИ ......186

4.3 3 КРАТЧАЙШИЕ НАДСТРОКИ В КАЧЕСТВЕ ПУТЕЙ . 189

4.3 4 ЖАДНЫЙ АЛГОРИТМ . .192

4.3.5. АЦИКЛИЧЕСКИЕ ПОДГРАФЫ.............195

4.4. ЭВРИСТИКИ ..............................202

4.4 1 ОБНАРУЖЕНИЕ ПЕРЕКРЫТИЙ.............205

4.4.2. УПОРЯДОЧЕНИЕ ФРАГМЕНТОВ...........206

4.4.3. ВЫРАВНИВАНИЕ И КОНСЕНСУС..........209

РЕЗЮМЕ.......................................211

УПРАЖНЕНИЯ . 212

БИБЛИОГРАФИЧЕСКИЕ ПРИМЕЧАНИЯ.................214

Глава 5. СОСТАВЛЕНИЕ ФИЗИЧЕСКИХ КАРТ ДНК 217

5.1. БИОЛОГИЧЕСКИЕ ОСНОВЫ КАРТИРОВАНИЯ.......217

5.1.1. СОСТАВЛЕНИЕ РЕСТРИКЦИОННЫХ КАРТ.219

5.1.2. СОСТАВЛЕНИЕ КАРТ ГИБРИДИЗАЦИИ ... 221

5.2. МОДЕЛИ..................................223

5.2.1. МОДЕЛИ УЧАСТКА РЕСТРИКЦИИ.........223

5.2 2 МОДЕЛЬ В ВИДЕ ИНТЕРВАЛЬНОГО ГРАФА .225

5.2.3 СВОЙСТВО ПОСЛЕДОВАТЕЛЬНЫХ ЕДИНИЦ . ..227

5.2 4 СВОЙСТВА «ИДЕАЛЬНОГО» АЛГОРИТМА КАРТИРОВАНИЯ .........................229

5.3. АЛГОРИТМ ДЛЯ ЗАДАЧИ СПЕ ................231

5.4. ПРИБЛИЖЁННОЕ СОСТАВЛЕНИЕ КАРТ ГИБРИДИЗАЦИИ 240

5.4.1. ГРАФОВАЯ МОДЕЛЬ...................241

5 4.2. ГАРАНТИЯ..........................244

5 4 3 ПРАКТИКА ВЫЧИСЛЕНИЙ................247

5.5. ЭВРИСТИКИ ДЛЯ СОСТАВЛЕНИЯ КАРТ ГИБРИДИЗАЦИИ25О 5.5.1 ОТСЕВ ХИМЕРНЫХ КЛОНОВ.............251

5.5.2. ПОЛУЧЕНИЕ ХОРОШЕГО ПОРЯДКА ЗОНДОВ 252

РЕЗЮМЕ..................................... 254

УПРАЖНЕНИЯ ..................................254

10

Оглавление

БИБЛИОГРАФИЧЕСКИЕ ПРИМЕЧАНИЯ . . .........257

ГЛАВА 6. ФИЛОГЕНЕТИЧЕСКИЕ ДЕРЕВЬЯ............260

6.1. СОСТОЯНИЯ ПРИЗНАКОВ И ЗАДАЧА О СОВЕРШЕННОЙ ФИЛОГЕНИИ............................ 263

6.2. СОСТОЯНИЯ БИНАРНЫХ ПРИЗНАКОВ..........269

6.3. ДВА ПРИЗНАКА..........................275

6.4. ЭКОНОМИЧНОСТЬ И СОВМЕСТИМОСТЬ ФИЛОГЕНЕТИЧЕСКИХ ДЕРЕВЬЕВ.........................280

6.5. АЛГОРИТМЫ ДЛЯ МАТРИЦ РАССТОЯНИЙ...... 284

6.5.1. ВОССТАНОВЛЕНИЕ АДДИТИВНЫХ ДЕРЕВЬЕВ . . 284

6.5.2. * ВОССТАНОВЛЕНИЕ УЛЬТРАМЕТРИЧЕСКИX ДЕРЕВЬЕВ ................................290

6.6. СОГЛАСИЕ ФИЛОГЕНЕТИЧЕСКИХ ДЕРЕВЬЕВ..... 299

РЕЗЮМЕ.................................... 305

УПРАЖНЕНИЯ ............................. 306

БИБЛИОГРАФИЧЕСКИЕ ПРИМЕЧАНИЯ...............309

ГЛАВА 7. ПЕРЕСТРОЙКИ ГЕНОМА.............. ... 312

7.1. БИОЛОГИЧЕСКИЕ ОСНОВЫ................. 312

7.2. ОРИЕНТИРОВАННЫЕ БЛОКИ................ 315

7.2.1. ОПРЕДЕЛЕНИЯ.....................317

7.2.2. ТОЧКИ РАЗРЫВА...................320

7.2.3. ДИАГРАММА ЖЕЛАЕМОГО И ДЕЙСТВИТЕЛБНОГО321

7.2.4. ГРАФ ПЕРЕМЕЖЕНИЙ................329

7.2.5. ПЛОХИЕ КОМПОНЕНТЫ.............. 333

7.2.6. АЛГОРИТМ....................... 336

7.3. НЕОРИЕНТИРОВАННЫЕ БЛОКИ.............. 340

7.3.1. ПОЛОСЫ......................... 342

7.3.2. АЛГОРИТМ....................... 345

РЕЗЮМЕ.....................................347

УПРАЖНЕНИЯ................................ 348

БИБЛИОГРАФИЧЕСКИЕ ПРИМЕЧАНИЯ...............350

ГЛАВА 8. ПРЕДСКАЗАНИЕ СТРУКТУРЫ МАКРОМОЛЕКУЛ 352

8.1. ПРЕДСКАЗАНИЕ ВТОРИЧНОЙ СТРУКТУРЫ РНК...353

8.2. СВЕРТЫВАНИЕ БЕЛКОВЫХ МОЛЕКУЛ..........362

8.3. ПРОТЯГИВАНИЕ БЕЛКОВ . 365

РЕЗЮМЕ.....................................372

Оглавление 11

ГЛАВА 9. ЭПИЛОГ: ВЫЧИСЛЕНИЯ С ПОМОЩЬЮ ДНК . ... 375

9.1. ЗАДАЧА О ГАМИЛЬТОНОВОМ ПУТИ .........375

9.2. ЗАДАЧА ВЫПОЛНИМОСТИ................379

9.3. ПРОБЛЕМЫ И ПЕРСПЕКТИВЫ........... ... 383

УПРАЖНЕНИЯ .............................385

БИБЛИОГРАФИЧЕСКИЕ ПРИМЕЧАНИЯ И ДРУГИЕ ИСТОЧНИКИ ................................385

ОТВЕТЫ К ИЗБРАННЫМ УПРАЖНЕНИЯМ........... 388

ЛИТЕРАТУРА................................395

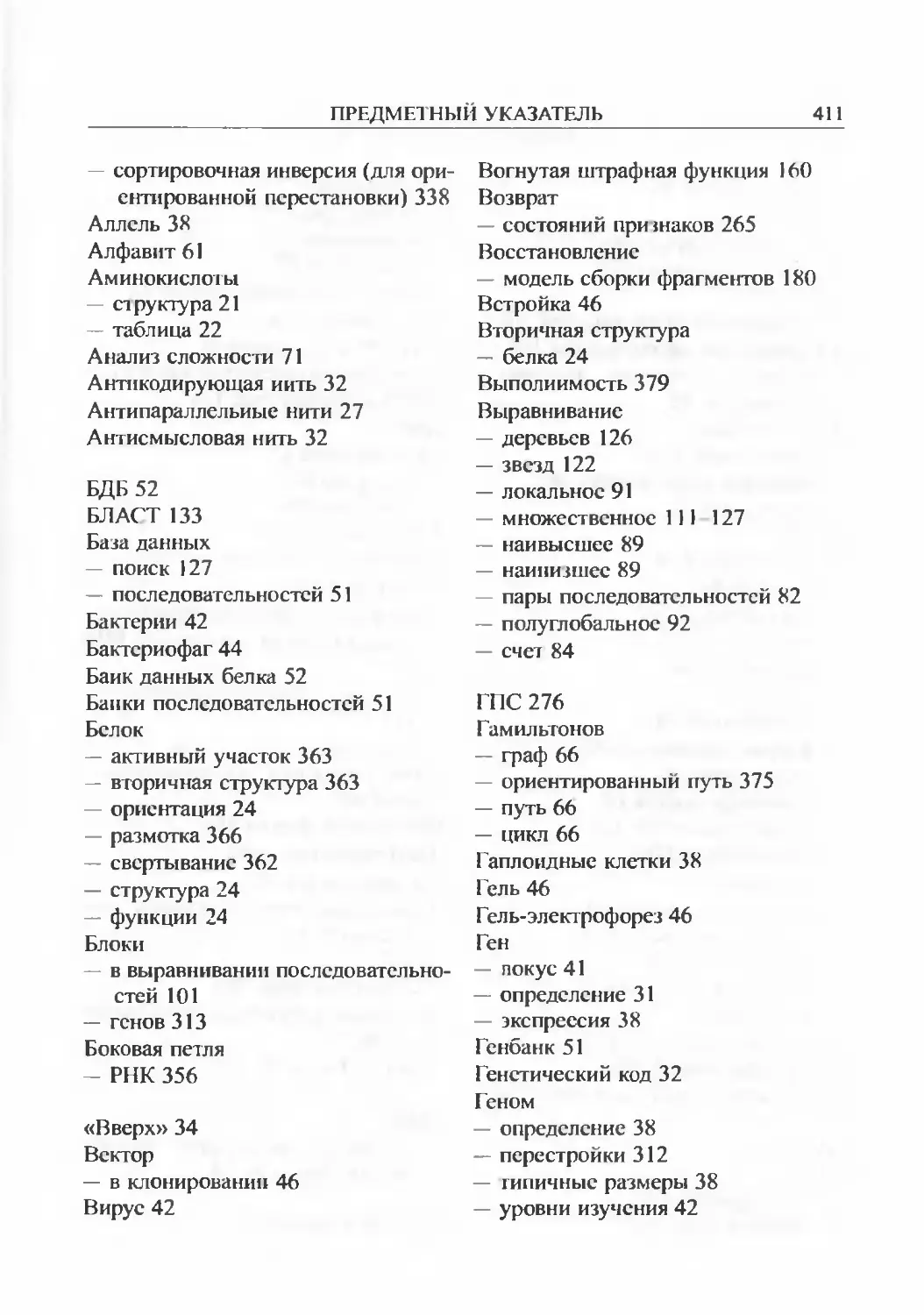

ПРЕДМЕТНЫЙ УКАЗАТЕЛЬ......................410

ПРЕДИСЛОВИЕ

Биология запросто посэавиг увлекательные задачи, над которыми нам придется поработать лет этак 500.

— Дональд Э Кнут

С того времени, когда в 1953 году была открыта структура двойной цепи ДНК, в развитии молекулярной биологии произошел гигантский скачок. По мере того как мы учились манипулировать последовательностями макромолекул, количество получаемых данных увеличивалось с огромной скоростью. Необходимость обработки информации, изливающейся из открытых по всему миру лабораторий, с тем чтобы она могла быть использована в дальнейшем научном прогрессе, породила качественно новые, междисциплинарные по своей природе задачи. Ученые-биологи являются производителями и в то же время конечными пользователями этих данных. Однако, вследствие гигантского объема и сложности информации, на пути от ее получения к использованию требуется помощь специалистов по многим другим дисциплинам - в частности, из области математических и вычислительных наук. Эта потребность привела к созданию новой научной отрасли, известной под общим названием вычислительной молекулярной биологии.

Название «вычислительная молекулярная биология» в самом широком смысле означает науку, занимающуюся разработкой и применением методов теории вычислительных систем и математики, которые могут помочь в решении задач молекулярной биологии. Несколько примеров пояснят вышесказанное.

Банки последовательностей и базы данных необходимы для хранения всей производимой информации. К настоящему времени уже создано несколько международных банков последовательностей, но ученые признали необходимость построения новых моделей баз данных, учитывающих специфические требования молекулярной биологии. Например, такие базы данных должны предоставлять ученым возможность вносить изменения в сведения о молекулярных последовательностях по мере их изучения; известные на сегодняшний день модели непригодны для этой цели. Исследование макромолекулярных последовательностей в свою очередь требу

ПРЕДИСЛОВИЕ

13

ет новых, усовершенствованных методов распознавания структуры, которые разрабатываются специалистами в области искусственного интеллекта С функцией поиска информации в базах данных связано появление новых и сложных статистических задач, для решения которых необходим постоянный поиск новых, специальных программных средств.

Однако существует особый класс задач, решение которых невозможно без построения эффективных алгоритмов. Попросту говоря, алгоритм это разбитая на последовательные шаги процедура решения определенной, хорошо структурированной задачи за ограниченный отрезок времени. Для того чтобы быть эффективным, алгоритм нс должен «чересчур долго» решать поставленную задачу, даже очень большую. Классический пример алгоритмически разрешимой задачи молекулярной биологии — задача сравнения последовательностей. Допустим, мы имеем две последовательности биополимеров и хотим знать, насколько эти последовательности подобны. Такую задачу приходится ежедневно решать тысячи раз, так что было бы весьма желательно иметь под рукой какой-нибудь особенно эффективный алгоритм.

Цель этой книги состоит в том, чтобы представить читателю типичные примеры вычислительных задач молекулярной биологии, а также некоторые эффективные алгоритмы, которые были предложены для их решения. Многие из этих задач были хорошо изучены, а некоторые из алгоритмов их решения известны уже много лет. Остальные задачи более сложны, и пока что не удалось найти никакого удовлетворительного алгоритмического подхода к их решению. В таких случаях мы сфокусировали наше внимание на объяснении некоторых математических моделей, которые могут быть использованы в качестве основы для построения необходимых алгоритмов в будущем

Читатель должен сознавать, что всякий алгоритм решения задач молекулярной биологии — любопытный инструмент. Он должен нравиться сразу двум мастерам: молекулярному биологу, который хочет, чтобы алгоритм был надежным, то есть решал задачу несмотря на все ошибки и неопре деленности, появляющиеся на практике, и программисту, который прежде всего заинтересован в гарантии того, что алгоритм решает хорошо структурированную задачу эффективно, и который обычно готов пожертвовать надежностью в пользу эффективности. Мы попытались найти некое равновесие между этими нередко противоречивыми требованиями, но в большинстве случаев мы принимали сторону программистов. В конце концов, это специальность авторов книги. Тем не менее, мы надеемся, что наше произведение будет в равной стеггени полезно как молекуггярным биологам, так и программистам.

14

ПРЕДИСЛОВИЕ

Настоящая книга является вводным курсом. Это означает, что один из наших руководящих принципов — познакомить читателя только с теми алгоритмами, которые мы сочли простыми, хотя это и не всегда было возможно. Для решения некоторых из представленных в книге задач существуют более эффективные и, как правило, более сложные алгоритмы; ссылки на некоторые из таких алгоритмов приведены в разделе библиографических примечаний в конце каждой главы.

Несмотря на нашу основную цель, некоторые из представленных нами алгоритмов или моделей нельзя счесть простыми. Как правило, это обусловлено сложностью соответствующей темы. Наиболее трудные места мы старались отмстить знаком звезды «*» в соответствующих заголовках или же дать необходимые пояснения в тексте. Кроме того, вводный характер книги означает, что некоторые темы предназначены в качестве отправной точки для непосвященных читателей. Весьма вероятно, а в некоторых случаях и факт, что этим темам можно было бы посвятить целые книги.

Основная аудитория предполагаемых адресатов учебника — студен гы специальностей из области математических и вычислительных наук. Мы нс предполагаем никакого дополнительного образования в сфере молекулярной биологии выше уровня средней школы и специально приводим главу, в которой кратко разъясняем основные понятия, встречающиеся в тексте. Читателей, не знакомых с молекулярной биологией, мы побуждаем выйти за рамки представленного в книге обзора и расширить свои познания, опираясь на куда более серьезные литературные источники, упомянутые в конце первой главы.

Хочется верить, что наша книга будет в некоторой мере полезна и для студентов-биологов. Мы предполагаем, что наш читатель знаком с дискретной математикой и теорией алгоритмов по крайней мерс на уровне колледжа. С целью помочь читателю, совершенно незнакомому с этими предметами, мы написали главу, содержашую краткий обзор всех основных понятий, употребляемых в настоящей книге.

Вычислительная молекулярная биология развивается очень быстро. Постоянно разрабатываются все более совершенные алгоритмы, а новейшие разделы этой дисциплины, очевидно, успеют возникнуть даже прежде, чем мы допишем это предисловие. В пределах упомянутых выше ограничений мы старались охватить, как мы считали, достаточно полную выборку тем и мы верим, что большая часть представленного здесь материала не потеряет свою значимость с течением времени.

Читателя, стремящегося к научным далям, мы снабдили указателями на некоторые источники информации; особенно много ссылок дано в библиографических примечаниях к последней главе (включая адреса интересных

ПРЕДИСЛОВИЕ

15

веб-страниц). Однако эти примечания не следует считать исчерпывающими. Кроме того, при всем нашем желании мы не можем гарантировать точность адресов страниц всемирной паутины. Мы их неоднократно проверяли, но, в силу динамической природы сети, к моменту выпуска книги они могли измениться.

ОБЗОР СОДЕРЖАНИЯ КНИГИ

Глава 1 знакомит читателя с фундаментальными понятиями молекулярной биологии В ней мы описываем основные структуры и функции белков и нуклеиновых кислот, механизмы молекулярной генетики, наиболее важные лабораторные методы изучения генома организмов, а также приводим краткий обзор существующих баз данных и банков последовательностей.

В главе 2 мы рассказываем о строках и графах — важнейших математических объектах, используемых в настоящей книге, а также сообщаем общие сведения об алгоритмах, проводим их анализ и поясняем основные определения из теории ПП-полноты.

Следующие главы посвящены специальным задачам молекулярной биологии. В главе 3 изложена методика сравнения последовательностей, изучена типичная задача сравнения пары последовательностей и представлен классический алгоритм метода динамического программирования. Далее рассмотрены расширения этого алгоритма, разработанные для решения специальных задач данного класса. Задаче множественного сравнения последовательностей посвящен отдельный раздел. В последующих разделах этой главы рассмотрены программы, используемые для поиска в базах данных, а также некоторые другие вопросы.

Глава 4 представляет задачу сборки фрагментов. Подобная задача возникает, когда последовательность ДНК разрезается на маленькие фрагменты, которые затем должны быть сшиты, с тем чтобы воссоздать последовательность исходной молекулы Данная методика широко применяется при крупномасштабном секвенировании (расшифровке последовательностей хромосом и даже целых геномов) — например, в проекте «Геном человека». Мы приводим примеры различных затруднений, возникающих при решении этой задачи. Далее мы представляем некоторые модели упрощенных вариантов задачи. В последующих разделах главы рассмотрены алгоритмы и эвристики, основанные на этих моделях.

В главе 5 представлена задача составления физических карт. Ее можно представить как задачу сборки фрагментов в большем, по сравнению с описанным в главе 4, масштабе. Здесь фрагменты макромолекул намного длиннее, и по этой причине методы сборки должны сильно отличаться

16

ПРЕДИСЛОВИЕ

от применяемых в предыдущем случае Цель составления физических карт заключается в том, чтобы определить местоположение специфических маркеров в исследуемой молекуле ДНК. Приведен также краткий обзор методов и моделей картирования. Далее мы описываем алгоритм для решения задачи с последовательными единицами; в составлении физических карт эта абстрактная задача играет ключевую роль. Глава заканчивается разделами, посвященными алгоритмам аппроксимации и эвристикам, разработанным для решения варианта задачи составления физических карт.

Так же, как и целые организмы, белки и нуклеиновые кислоты изменяются в процессе смены поколений, и важным инструментом в понимании путей их эволюции является филогенетическое дерево объектов. Помимо этого, филогенетические деревья помогают лучше понять функции белков В главе 6 описаны некоторые математические задачи, связанные с восстановлением филогенетических деревьев, а также простые алгоритмы, разработанные для некоторых частных случаев.

Совсем недавно в вычислительной биологии появилась новая важная область, занимающаяся исследованиями перестроек генома. Было обнаружено, что у некоторых организмов генетические различия на уровне после довательностей нуклеотидов практически незаметны, однако проявляются на уровне длинных фрагментов ДНК. Для изучения различий данного типа были разработаны интересные математические модели, представленные в главе 7.

Понимание биологических функций макромолекул является, по сути, основой большинства задач вычислительной биологии. Поскольку эти молекулы свертываются в трехмерном пространстве, а их функции зависят от их специфической конформации, открытие трехмерной структуры биомолекул и, в частности, строения РНК и белков, вызывало первостепенный интерес ученых в течение нескольких последних десятилетий.

Это событие стимулировало развитие методов предсказания сложной структуры макромолекул на основании их первичной структуры, то есть последовательности мономеров. В главе 8 мы описываем алгоритмы метода динамического программирования, разработанные для предсказания струк туры РНК, приводим краткий обзор затруднений, связанных с прсдсказани ем структуры белка, и представляем очень важный недавно разработанный метод, называемый протягиванием белка, которое заключается в выравнивании последовательности исследуемого белка с моделью уже известной белковой структуры.

Глава 9 завершает книгу, представляя описание новой захватывающей области — вычислений с помощью ДНК. В этой главе мы описываем основной эксперимент, показавший возможность использования молекул ДНК

ПРЕДИСЛОВИЕ

17

для решения одной трудной алгоритмической задачи, а также теоретические основы алгоритма решения другой трудной задачи.

Оговорим некоторые обозначения, принятые в этой книге. Как уже было упомянуто, разделы, заголовки которых отмечены знаком звезды «*», содержат материал, который авторы считают наиболее трудным. Условимся, что полужирным шрифтом мы будем выделять важные термины, относящиеся ко всему материалу книги. Все остальные термины будут выделены курсивом. Многие из разработанных нами алгоритмов сначала описаны в виде простых предложений, а затем в форме псевдокодов (язык псевдокодов описан в разделе 2.3). В некоторых случаях псевдокод обеспечивает уровень детализации, необходимый читателям, заинтересованным в практической реализации алгоритмов.

Изложение материала наиболее длинных глав сопровождается кратким резюме.

УПРАЖНЕНИЯ

В конце каждой главы даны упражнения. Упражнения, отмеченные одной звездой «*» трудны, но выполнимы менее чем за день. Для этого могут потребоваться методы программирования, не представленные в данной книге. Задачи, отмеченные двумя звездами «**», в свое время были исследованы и решены, а их решения можно найти в специальной литературе (соответствующие ссылки находятся в библиографических примечаниях в конце глав). Наконец, упражнения, отмеченные знаком алмаза «о», содержат сложные задачи, которые, насколько известно авторам, так и нс были решены.

В конце книги мы приводим ответы и подсказки к избранным упражнениям.

ОШИБКИ

Несмотря на кропотливый труд авторов, в этой книге наверняка присутствуют некоторые ошибки. Мы будем рады получать ваши замечания и предложения по усовершенствованию нашего учебника. Сообщения об ошибках или любые другие комментарии отправляйте по адресу: bio@dcc.unicamp.br или

J. Meidanis / J. С. Sctubal

Institute de ComputaQao, С. P. 6176

UNICAMP

18

ПРЕДИСЛОВИЕ

Campinas, SP 13083-970

Brazil.

(С авторами можно непосредственно связаться по адресам электронной почты meidanis@dcc.unicamp.br и setubal@dcc.unicamp.br.) Заранее благодарим всех читателей, желающих оказать нам помощь в улучшении этой книги. По мере обнаружения ошибок мы будем сообщать о них на следующей веб-странице:

http: //www. dec. unicamp. br/~bio/ICMB. html

БЛАГОДАРНОСТИ

Эта книга — преемник другой, намного более краткой книги по тому же предмету, написанной авторами в Португалии и изданной в 1994 году в Бразилии. Изданию той первой книги во многом способствовала проводимая каждые два года Бразильская конференция по информатике, названная «Эскола ди компутасан». Мы полагаем, что без участия в конференции подобного уровня мы не писали бы сейчас это предисловие, и благодарны за такую возможность.

Настоящая книга начала свою жизнь во многом благодаря Майку Шу-гермену, Бонни Бергер и Тому Литону. Они оказали нам большую поддержку, а также дали некоторые полезные советы. Особенно ценной помощью оказались копии конспектов лекций Бонни, любезно предоставленные нам в начале работы над книгой.

К счастью, нам удалось получить финансовые гранты от FAPESP и CNPq (бразильские научно-исследовательские учреждения); их помощь была многоплановой. Гранты от FAPESP были предоставлены в рамках проекта «Лаборатории алгоритмов и комбинаторики» и обеспечили нам покупку компьютерного оборудования. Гранты от CNPq были предоставлены в форме индивидуальных стипендий на проведение научно-исследовательских работ, а также, в рамках программы PROTEM и проектов PROCOMB и ТСРАС, были направлены на финансирование научных командировок.

Мы благодарим наших студентов, которые помогали нам при чюнии корректуры рукописи. Особую благодарность выражаем Налву Франку ди Алмейде младшему и Марии Эмилии Машаду Телльз Уолтер. Налву, кроме того, сделал много рисунков и дал несколько полезных комментариев.

Беседы с нашим коллегой Жоржи Стольфи были весьма полезны, и, кроме того, он оказал нам значительную помощь в вопросах, связанных

ПРЕДИСЛОВИЕ

19

с набором текста. Фернанду Рейнаш и Жилсон Паулу Манфиу помогли нам при написании главы 1. Назначение и задачи книги, а также прочие вопросы общего плана мы обсуждали с Джимом Орлином. Мартин Фарах и Сампат Каннан, а с ними еще несколько рецензентов, внесли много полезных предложений и замечаний, некоторые из которых были включены в текст учебника. Наши коллеги в «Институте вычислений в UNICAMP» оказывали нам искреннюю поддержку и создавали рабочую обстановку, способствовавшую продуктивной творческой деятельности.

Следует поблагодарить многих коллег, любезно присылавших нам научные статьи: Фарида Ализаде, Альберто Капрару, Мартина Фараха, Дэвида Гринберга, Дэна Гасфильда, Сридара Ханненхалли, Вэнь-Лянь Сю, Сяоцю Хуана, Тао Цзяна, Джона Кецециоглу, Лукаса Кнехта, Рика Лэтропа, Джина Майерса, Алехандро Шеффера, Рона Шамира, Мартина Вингрона (который, ко всему прочему, прислал конспекты своих лекций), Тодда Уэрхема и Тенди Уорноу. При работе над некоторыми разделами книги мы широко использовали материал некоторых из этих статей.

Большое спасибо мы говорим Эрику Бриссону, Эйлин Салливан, Брюсу Дейлу, Карлусу Эдуарду Феррейре и Томасу Русу, которые всячески помогали нам в работе.

Ж. К. С. хочет поблагодарить своих близких: жену Сильвию (Теку) и детей Клаудию, Томаса и Каю за оказанную ими поддержку, без которой эта книга, возможно, не была бы написана.

При наборе текста авторы использовали систему Лесли Лэмпорта IAlgX2e, работающую на ТрХ-системе Дона Кнута. Это поистине изумительные программы!

Цитату Дона Кнута, приведенную в качестве эпиграфа к предисловию, мы взяли из интервью, данного им «Компьютер литераси букшопс, инк.» 7 декабря 1993 года.

Жуан Kap.iyc Ссгубал

Жуан Мсйдаиис

Глава 1

ОСНОВНЫЕ ПОНЯТИЯ МОЛЕКУЛЯРНОЙ БИОЛОГИИ

В згой главе мы представляем основные понятия молекулярной биологии. Ваша цель здесь состоит в том, чтобы дать нашим читателям надежные ориентиры и они могли бы свободно лавировать не только в биологическом контексте этой книги, но и в море остальной литературы по вычислительной молекулярной биологии. Читатели, ранее специализировавшиеся в точных науках, должны с самого начала быть готовы к тому, что в молекулярной биологии ничто не будет действительно точным на 100 %. К каждому правилу всегда найдется свое исключение. Мы попытались указать некоторые из наиболее примечательных исключений к общим правилам, в остальных же случаях опускали такое упоминание, с тем чтобы не превращать эту главу в самостоятельный учебник по молекулярной биологии.

1.1. ЖИЗНЬ

В природе мы встречаем как живые, так и неживые объекты. Живые природные объекты способны передвигаться, воспроизводить себе подобных, расти, питаться, и т. д. — словом, они принимают активное участие в процессах окружающей среды, в отличие от неживых форм. Однако результаты исследований за последние столетия показывают, что оба вида материи состоят из одних и тех же атомов и подчиняются одним и тем же физическим и химическим законам. Но в чем же тогда заключается различие между ними?

В течение длительного периода человеческой истории люди думали, что некоторый вид «сверхматерии» даровал живым существам их активные характеристики, — что они «одушевлялись» этой особой субстанцией. Но до сих пор ничего подобного так и не удалось обнаружить. Напротив, наши современные представления свидетельствуют о том, что живые сушества организованы именно так, как они есть, а не иначе, в силу множества происходящих в них сложнейших химических реакций. Эти реакции никогда не

1.2. БЕЛКИ

21

прекращаются. Часто продукты одной реакции сразу же включаются в следующую, и такой принцип поддерживает непрерывное функционирование системы (организма) в целом. Кроме того, живой организм постоянно обменивается с окружающей средой материей и энергией. Напротив, что-либо, находящееся в равновесии с окружающей средой, можно, как правило, считать мертвым. (Некоторые известные исключения — вегетативные формы жизни наподобие семян и вирусов, которые могут быть абсолютно неактивными в течение длительных периодов времени, и несмотря на это нельзя сказать, что они мертвы.)

Современная наука показала, что жизнь зародилась приблизительно 3,5 миллиарда лет назад, вскоре (в геологических сроках) после того, как была сформирована и сама планета Земля Первые формы жизни были весьма примитивны, но непрерывно действующий процесс, названный эволюцией, который в течение миллиардов лет заставлял их развиваться и изменяться, привел к тому, что сегодня мы можем встретить как очень сложные организмы, так и совсем простые.

И сложные и простые организмы имеют сходную молекулярную химию, или биохимию. Главные актеры в химии жизни — молекулы белков и нуклеиновых кислот. Описывая их функции в общих чертах, можно сказать, что белки определяют специфическую организацию и физиологические функции живых организмов. (Выдающийся ученый Расселл Дулиттл однажды сказал: «Мы — это наши белки».) Нуклеиновые кислоты, с своей стороны, кодируют информацию, необходимую для производства белков, и отвечают за передачу этого «рецепта» последующим поколениям.

Молекулярная биология, в основном, занимается исследованием структуры и функций белков и нуклеиновых кислот. Поэтому эти молекулы являются фундаментальными объектами настоящей книги, и мы продолжаем наш рассказ вводным и кратким описанием современного представления о них

1.2. БЕЛКИ

Большая часть веществ, из которых состоят наши тела, — белки самых разнообразных форм и функций Структурные белки являются строительным материалом тканей, тогда как белки другого класса, называемые ферментами, - действую! как катализаторы химических реакций. Катализаторами называют вещества, ускоряющие химические реакции. Если бы многие биохимические реакции протекали самопроизвольно, то для их завершения потребовалось бы слишком много времени, или они не заверши

22

Глава 1

лись бы вовсе, а потому были бы совершенно бесполезны для отправления жизненных функций. Фермент может увеличить скорость протекания реакции на несколько порядков, таким образом делая жизнь возможной. Ферменты чрезвычайно специфичны: как правило, отдельный фермент может воздействовать на биохимическую реакцию только определенного типа. Если представить себе количество реакций, протекание которых необходимо для поддержания жизни, то становится очевидным, что организм нуждается в большом числе разнообразных ферментов. Другими примерами функций белка являются перенос кислорода и антителогенез. Но что же на самом деле представляют собой белки? Как они устроены? И как они выполняют свои функции? В данном разделе мы попытаемся кратко ответить на все эти вопросы.

Макромолекула белка устроена в виде цепи более простых молекул, называемых аминокислотами. Примеры структурных формул аминокислот приведены на рие. 1.1. Каждая аминокислота содержит один центральный углеродный атом, который получил название «альфа-углерод» и был обозначен CQ. С атомом CQ соединены водородный атом, аминогруппа (NH2), карбоксильная группа (СООН) и боковая цепь. Именно боковая цепь отличает одну аминокислоту от другой. Боковые цепи могут быть совершенно простыми и состоять лишь из одного водородного атома (аминокислота глицин) или сложными и содержать в себе, например, два углеродных кольца (триптофан). Всего в природе обнаружено 20 различных аминокислот, названия и обозначения которых приведены в таблице 1.1. Эти 20 аминокислот являются наиболее общими компонентами всех белков; иногда в их состав могут входить лишь несколько нестандартных аминокислот.

НО СН3

СН3 СН

H2N — Са — СООН H2N — са — СООН

Н Н

Рис. 1.1. Аминокслоты: аланин (слева) и треонин (справа)

В белковых макромолекулах аминокислоты соединены посредством пептидных связей, в результате чего они образуют полипептидные цепи.

1.2. БЕЛКИ

23

Таблица 1.1. Двадцать «популярных» аминокислот1

Однобуквенный Трехбуквенный код Название

код

1 А Ala Ала аланин

2 С Cys Цис цистеин

3 D Asp Acn аспарагиновая кислота

4 Е Glu Глу глутаминовая кислота

5 F Phe Фен фенилаланин

6 G Gly Гли глицин

7 Н His Гис гистидин

8 I He Иле изолейцин

9 К Lys Лиз лизин

10 L Leu Лей лейцин

И М Met Мет метионин

12 N Asn Асн аспарагин

13 Р Pro Про пролин

14 Q Gin Глн глутамин

15 R Arg Apr аргинин

16 S Ser Сер серин

17 Т Thr Тре треонин

18 V Vai Вал валин

19 W Trp Трп триптофан

20 Y Tyr Тир тирозин

В пептидной связи углеродный атом, принадлежащий карбоксильной группе аминокислоты А,, соединен с атомом азота, входящим в аминогруппу аминокислоты А,+з. При образовании такой связи высвобождается молекула воды, поскольку кислород и водород карбоксигруппы присоединяются к одному водородному атому аминогруппы. Следовательно, в качестве звеньев цепи полипептида в действительности выступают остатки исходных аминокислот. Таким образом, о некотором белке мы можем сказать, что он состоит, например, из 100 остатков, а нс из 100 аминокислот. Обычные белки содержат около 300 остатков, но известны также белки, содержащие всего 100 или целых 5 000 аминокислотных остатков.

’Для обозначения аминокислот используют одно- и трехбуквенный код. Трехбуквенные обозначения более удобны для чтения, а однобуквенные для компьютерного анализа* 2. Прим. ред.

2 Для отличия однобуквенных обозначений нуклеотидов и аминокислот первые принято (однако не все авторы соблюдают это условие сравните обозначения нуклеотидов в тексте кни! и

24

Глава 1

Пептидная связь обусловливает наличие в каждой белковой молекуле основной цепи, образованной повторными структурными звеньями вида N С„(СО). Каждому атому Со соответствует боковая цепь (см рис. 1.2) Поскольку на одном конце основной цепи находится ами ногруппа, а на другом — карбоксигруппа, мы можем различать оба конца полипептидной цепи и придать ей условное направление. Принято считать, что полипептиды начинаются аминогруппой (N-конец) и оканчиваются карбоксигруппой (С-конец).

Рис. 1.2. Полипсптидиая цепь. Боковые цени R, определяют входящие в состав белка аминокислоты. Атомы внутри каждой четырехугольной рамки лежат в олной плоскости, которая может вращаться на у1лы ф и ф

Однако большая часть белков представляют собой не простые линейные последовательности аминокислотных остатков (такая последовательность называется первичной структурой белка), а свертываются в трех измерениях, образуя вторичную, третичную и четвертичную структу ры. Вторичная структура белка формируется посредством взаимодействия только между атомами основной цепи и проявляется в виде «локальных» структур например спиралей. Третичные структуры — результат вторичной укладки белковой структуры на более высоком уровне Следующий уровень укладки, то есть четвертичную структуру, образует группа различных белков, собранных в одну сложную макромолекулу. Эти структуры схематично изображены на рис. 1.3.

Белки могут свертываться в трех измерениях, поскольку плоскость связи между атомом Со и атомом азота может вращаться, так же, как и плоскость между атомом Са и другим углеродным атомом. Эги углы вращения

и в примерах записей баз .чанных) набирают строчными буквами, а вторые — прописными. Таким образом, запись «atg» обозначает последовательность нуклеотидов аденин тимин- гуанин, а запись «ATG» - последовательность остатков аминокислот Ала Тре-Гли. Прим перев.

1.2. БЕЛКИ

25

Рис. 1 3 Первичная, вторичная, третичная и четвертичная структуры белка [28]

обозначаются, соответственно, греческими буквами ф и Ф (см. рис. 1.2). Боковые цепи также способны вращаться, но это уже вторичное вращение по отношению к вращению основной цепи. Таким образом, если мы определим значения всех пар углов ф-ф в молекуле белка, то мы узнаем точную конформацию основной цепи.

Определение рабочей конформации, или трехмерной структуры белка является одной из главных областей исследования в молекулярной биологии по трем причинам. Во-первых, трехмерная структура белка непосредственно определяет его функции. Во вторых, клеточный механизм, который составляет белковую молекулу из набора аминокислот 20 различных видов, делает конечную трехмерную структуру во многих случаях очень сложной и асимметричной. В-третьих, не известно ни одного простого и точного метода определения трехмерной структуры белка. Эти причины побудили нас к написанию главы 8, где мы рассматриваем некоторые методы предсказания сложной структуры молекул по последовательностям входящих в их состав мономеров.

Трехмерная структура белка определяет его функцию следующим образом. Свернутый белок имеет неправильную форму. Это означает, что в его молекуле есть различные бороздки и выступы, и эти особенности формы позволяют белку входить в тесный контакт, или связываться, с некоторыми другими специфическими молекулами. Виды молекул, с которыми может связываться белок, зависят от его формы. Например, форма белка может быть такой, что он способен связываться с несколькими идентичными копиями самого себя, выстраивая, скажем, нить волоса Или же его форма может быть такой, что молекулы вида 4 и В связываются с ним и начинают обмениваться атомами между собой. Другими словами, между веществами А и В происходит реакция, а белок выступает в роли катализатора.

26

Глава 1

Но каким образом организм получает необходимые ему белки? Белки производятся в клеточных структурах, называемых рибосомами. В рибосоме аминокислоты, входящие в состав белка, собираются одна за другой в полипептидную цепь благодаря информации, содержащейся в очень важной молекуле информационной рибонуклеиновой кислоты. Прежде чем объяснить механизм этих процессов, мы должны рассказать о нуклеиновых кислотах.

1.3. НУКЛЕИНОВЫЕ КИСЛОТЫ

Живые организмы содержат два вида нуклеиновых кислот: рибонуклеиновую кислоту (РНК) и дезоксирибонуклеиновую кислоту (ДНК). Сначала опишем ДНК.

1.3.1. ДНК

Подобно белкам, молекулы ДНК построены в виде цепи более простых молекул Фактически это двойная цепь, но сначала рассмотрим структуру простой одинарной цепи, называемой нитью. Несущая структура нити представлена основной цепью, состоящей из одинаковых повторных звеньев. Мономерное звено образовано молекулой сахара, а именно 2'-дезоксирибозой, с которой соединен фосфатный остаток. В молекулу сахара входит пять углеродных атомов, обозначаемых, соответственно, цифрами с 1' по 5' (см. рис. 1.4).

Связи, образующие основную цепь, находятся между З'-углеродным атомом одного звена и остатком фосфата, а также между этим остатком

Н

НО-5'-Н

Н

Н0-5'-Н

I I

НО ОН

рибоза 2'дезоксирибоза

Рис. 1.4 Сахара, входящие в состав нуклеиновых кислот Цифры с 1' по 5' обозна чают углеротиые азомы. Единственная разница между двумя сахарами заключается в наличии или отсутствии атома кислорода при углеродном атоме 2'. Рибоза входит в состав РНК, а 2'-дсзоксирибоза — в состав ДНК

1.3. НУКЛЕИНОВЫЕ КИСЛОТЫ

27

Рис. 1.5. Азотистые основания, входящие в состав ДНК. Точечными линиями отмечены связи, которые могут образовывать аденин с тимином или зуанип с ни го (ином

и 5'-углеродным атомом следующего звена. По этой причине молекулы ДНК имеют условную ориентацию; также принято считать б'-конец началом нити, а З'-консц — се окончанием. Когда мы видим изображение последовательности нуклеотидов одинарной цепи ДНК на технической бумаге, в книге или файле базы данных последовательностей, она всегда записана в этом каноническом направлении 5' —> 3', если не оговорено противное.

К l'-углсродному атому каждого звена основной цепи присоединены другие молекулы, называемые основаниями3. В природных биополимерах встречаются азотистые основания четырех видов: аденин (А), гуанин (G), цитозин (С) и тимин (Т). На рис. 1.5 представлены структурные формулы молекул этих оснований, а на рис. 1.6 изображено схематичное представление одной нити ДНК, которую мы только что рассмотрели. Основания А и G входят в группу веществ, названных пуринами, тогда как основания С и Т относятся к пиримидинам.

Когда мы рассматриваем фрагмент молекулы ДНК, состоящий из моносахарида, фосфата и азотистого основания, в качестве мономерного звена, мы называем его нуклеотидом. Таким образом, хотя основания и нуклеотиды — не одно и то же, мы можем говорить, что молекула ДНК содержит,

’Здесь и далее азотистые основания. — Прим, перев.

28

Глава 1

Рис. 1.6. Схематическое представление одной нити ДНК: Ф — фосфат; М — моносахарид; G. А, С, Т соответственно, гуанин, аденин, цитозин и тимин

например, 200 оснований или 200 нуклеотидов. Молекулу ДНК, включающую в себя несколько (десятки) нуклеотидов, называют олигонуклеотидом. Природные молекулы ДНК очень длинные - намного длиннее молекул-полипептидов. В клетках человека находятся молекулы ДНК, состоящие из сотен миллионов нуклеотидов.

Как было упомянуто выше, молекулы ДНК образованы двумя нитями. Две нити связаны вместе и закручены в виде спиральной структуры — знаменитой двойной спирали, открытой Джеймсом Уотсоном и Фрэнсисом Криком в 1953 году. Но каким образом две нити удерживаются вместе? Такая связь возможна благодаря тому, что каждое азотистое основание, расположенное в одной нити, образует пару (связывается) с некоторым основанием другой нити. Основание А всегда взаимодействует с основанием Т, а основание С — только с G, как показано на рис. 1.5 и 1.7. Говорят, что основания А и Т являются комплементами друг друга и образуют пару комплементарных оснований. В свою очередь, С и G — другая пара комплементарных оснований. Данные пары известны как пары оснований Уотсона-Крика. Пара оснований (сокращенно — по) является единицей длины, наиболее удобной при обозначении длины молекул ДНК. Так что мы говорим, что длина фрагмента ДНК равна, например, 100000 по или 100 кпо4.

В этой книге мы будем, в основном, рассматривать последовательность ДНК как строку знаков, где каждый знак обозначает соответствующее основание. На рис. 1.8 показано такое «строчное представление» двойной цепи ДНК, при котором одна строка помещается над другой. Обратите внимание на парность оснований. Даже при том, что обе нити связаны между собой,

4Очевидио, что в каждой молекуле ДНК число пар азотистых оснований равно числу пар нуклеотидов. Английская единица Ьр (по) подчеркивает; что пары образуют именно комплементарные основания; напротив, принятая в российской научной литературе единица п. н. показывает, что общая длина полинуклеотида складывается из сумм его мономерных звеньев нуклеотидов.

Таким образом, Ьр = п. и.; kbp = т. п. н.: mbp = м. п. н. - Прим, перев.

1.3. НУКЛЕИНОВЫЕ КИСЛОТЫ

29

каждая сохраняет свою собственную ориентацию и эти ориентации взаимно противоположны. Этот факт проиллюстрирован на рис. 1.8., где хорошо видно, что З'-конец одной нити соответствует б'-концу другой нити. Это свойство получило название антипаралчельности нитей. Фундаментальное следствие подобной структуры заключается в том, что, определив последовательность одной нити, возможно восстановить последовательность другой. Действие, которое позволяет нам сделать это, называют обратной комплементацией.

Например, задана последовательность s AGACGT в каноническом направлении, и мы получаем ее обратный комплемент следующим образом. Сначала мы записываем последовательность s в обратном порядке, получая обратную последовательность s' = TGCAGA, а затем заменяем каждое основание его комплементом и получаем обратную комплементарную последовательность s = ACGTCT. (Для обозначения обратного комплемента последовательности s мы используем знак черточки над s.) Именно эти действия выполняет клеточный механизм, обеспечивающий репликацию ДНК в клетке, что позволяет организму, начавшему жизнь с одной-единственной клетки, последовательно превратиться в систему, насчитывающую миллиар-

5' — TACTGAA — 3'

3' — ATGACTT — 5'

Рис. 1.8. Строчное представление двойной цепи ДНК

30

Глава 1

ды клеток, где каждая клетка содержит копии молекул ДНК первоначальной клетки.

В организмах, построенных из безъядерных клеток ДНК свободно плавает в цитоплазме. У высших организмов ДНК находится в клеточном ядре, а также в особых органеллах клетки — митохондриях (животные и растения) и хпоропластах (только растения).

1.3.2. РНК

Молекулы РНК во многом подобны молекулам ДНК, но имеют некоторые отличия состава и структуры:

• В РНК моносахарид представлен рибозой вместо 2'-дезоксирибозы (см. рис 1.4).

• В РНК вместо тимина (Т) присутствует урацил (U). Подобно тимину, урацил связывается с аденином.

• РНК не образует двойную спираль. Иногда мы наблюдаем гибридные ДНК-РНК спирали; кроме того, благодаря комплсментарности оснований отдельные части молекулы РНК могут связываться с другими частями той же молекулы. Трехмерная структура РНК представлена гораздо большим числом форм, чем таковая у ДНК.

Еще одно различие между ДНК и РНК заключается в том, что по существу ДНК выполняет лишь одну функцию (кодирование информации), тогда как, как мы вскоре увидим, в клетке имеются различные виды РНК, выполняющие разнообразные функции.

1.4. МЕХАНИЗМЫ МОЛЕКУЛЯРНОЙ ГЕНЕТИКИ

Значение молекул ДНК состоит в том, что в них закодирована информация, необходимая для построения всех молекул белков или РНК, функционирующих в организме. По этой причине ДНК иногда называют «матрицей жизни»5. В этом разделе мы опишем механизмы кодирования информации и построения белка с помощью ДНК (процесс синтеза белка). Мы также увидим, каким образом заложенная в ДНК генетическая информация передается от родителей к потомству.

1.4.1. ГЕНЫ И ГЕНЕТИЧЕСКИЙ КОД

В каждой клетке организма находится несколько очень длинных молекул ДНК. Эти молекулы называют хромосомами. Позже мы сможем по-

5 Другое название — «молекула жизни». — Прим, перев.

1.4. МЕХАНИЗМЫ МОЛЕКУЛЯРНОЙ ГЕНЕТИКИ

31

Таблица 1.2. Универсальный генетический код6

Первая позиция Вторая позиция Третья ПОЗИЦИЯ

G A С U

Gly Glu Ala Vai G

G Gly Glu Ala Vai A

Gly Asp Ala Vai C

Gly Asp Ala Vai U

Arg Lys Thr Met G

А Arg Lys Thr He A

Ser Asn Thr He C

Ser Asn Thr He U

Arg Gin Pro Leu G

С Arg Gin Pro Leu A

Arg His Pro Leu C

Arg His Pro Leu U

Trp СТОП Ser Leu G

и СТОП стоп Ser Leu A

Cys Туг Ser Phe C

Cys Туг Ser Phe U

дробнее рассказать о хромосомах, а в данный момент рассмотрим принципы кодирования генетической информации на примере одной очень длинной молекулы ДНК, которую мы просто будем называть «ДНК». Первая важная вещь, о которой следует упомянуть, — то, что цепь ДНК состоит из смежных участков, либо кодирующих, либо не кодирующих информацию, используемую в синтезе белков. Вторая важная вещь — то, что каждому конкретному виду белка в организме обычно соответствует один и только один участок ДНК. Этот участок получил название ген. Поскольку некоторые гены кодируют РНК, более корректно определять ген как непрерывный участок ДНК, содержащий информацию, необходимую для построения белка или молекулы РНК. Длины генов варьируют; гены человека могут иметь длину приблизительно 10000 п. н. Определенные клеточные механизмы способны точно распознавать в последовательности ДНК точки начала и конца каждого гена6 7.

6Редкая аминокислота селеноцистеин обозначается буквой и и трехбуквенным кодом Sec (Сец). Стоп-кодон обозначается буквой X. При.», перев.

7В современной молекулярной биологии понятие «ген» стало гораздо более расплывчатым и трудно определимым. Прим. ред.

32

Глава 1

Белок, как было показано выше, представляет собой цепь аминокислотных остатков. Поэтому все, что необходимо для того, чтобы «определить» белок, — это определить каждую аминокислоту, входящую в его состав. Именно эту операцию и выполняет молекула ДНК, используя триплеты нуклеотидов для кодирования всех аминокислот. Нуклеотидный триплет называют кодоном. Таблица соответствия всех возможных триплетов аминокислотам и есть так называемый генетический код (см. табл. 1.2). В таблице, как это видно, триплеты нуклеотидов приведены с учетом состава последовательности РНК, а не ДНК. Это связано с тем, что именно молекулы РНК обеспечивают связь между ДНК и непосредственным синтезом белка в процессе, который мы вскоре покажем в деталях. А пока что подробнее рассмотрим генетический код.

Интересно отметить, что существует 64 возможных триплета нуклеотидов, но всего только 20 аминокислот, которые нужно кодировать. Оказывается, одной и той же аминокислоте может соответствовать несколько триплетов. Например, кодоны AAG и ААА кодируют лизин. Напротив, три кодона в таблице не кодируют никакую аминокислоту, а служат сигналом окончания гена. Эти специальные, терминирующие кодоны обозначены в таблице 1.2 словом «стоп». Наконец, следует упомянуть, что генетический код, приведенный в таблице, используется подавляющим большинством живых организмов, однако некоторые организмы используют несколько видоизмененный код.

1.4.2. ТРАНСКРИПЦИЯ, ТРАНСЛЯЦИЯ И СИНТЕЗ БЕЛКА

Теперь немного подробнее опишем процессы, посредством которых зашифрованная в молекуле ДНК генетическая информация реализуется в белках. Клеточный механизм распознает начало отдельного гена или целой группы генов благодаря промотору. Промотор — это участок ДНК, расположенный перед каждым геном и указывающий клеточному механизму, что непосредственно за ним начинается ген. Кодон AUG (кодирующий метионин) также сигнализирует начало гена8. После распознавания начала гена или группы генов, на молекуле РНК синтезируется копия этого гена. В результате образуется информационная РНК, или, сокращенно, иРНК, которая имеет точно такую же последовательность нуклеотидов, как одна из нитей участка ДНК, содержащего копируемый ген. но с заменой основания Т на U. Данный процесс называют транскрипцией. После этого синтезированная

83десь существенная неточность. Промотор указывает место, с которого надо начинать синтез РНК, тогда как кодон AUG указывает на начало кодирующей области РНК, причем таким указателем служит далеко не каждый триплет AUG. — Прим. ред.

1.4. МЕХАНИЗМЫ МОЛЕКУЛЯРНОЙ ГЕНЕТИКИ

33

цепь иРНК участвует в процессе синтеза белка, происходящего в клеточных структурах, называемых рибосомами9.

Поскольку РНК является одинарной, а ДНК — двойной цепью, последовательность произведенной иРНК идентична одной нити гена и комплементарна другой его нити (с учетом замены основания Т на U). Нить, идентичную синтезированной иРНК, называют смысловой или кодирующей нитью, а другую — антисмысловой, или антикодирующей, или же, иначе, матричной нитью. Фактически транскрибируется именно матричная нить, так как цепь иРНК состоит из рибонуклеотидов, комплементарных этой нити. В процессе транскрипции наращивание цепи иРНК всегда ведется от б'-конца к З'-концу, тогда как матричная нить считывается в направлении 3' —> 5'.

Также необходимо помнить, что матричная нить для разных генов не всегда одна и та же: например, матричная нить для некоторого гена А может быть первой из двух нитей, а матричная нить для гена В может быть второй нитью. Клеточный механизм распознает матричную нить для каждого конкретного гена благодаря промотору. Даже при том, что в другой нити находится обратный комплемент промотора гена, этот обратный комплемент не является его промотором и, следовательно, не будет распознан в качестве такового.

Одно важное следствие из этого факта — то, что гены в хромосомах имеют ориентацию друг относительно друга. Если какие-либо два гена находятся в одной и той же нити, то они имеют одинаковую ориентацию; в противном случае их ориентация будет встречной. Фундаментальное значение этого факта мы раскроем в главе 7. Наконец, обращаем ваше внимание, что для указания расположения какого-либо участка в молекуле ДНК относительно ориентации кодирующей нити, используют термины выше и ниже', например, промоторы всегда расположены выше своих генов.

Описанный вариант транскрипции относится к организмам, принадлежащим к надцарству доядерных, или прокариотов. ДНК данных организмов свободно плавает в цитоплазме клетки, поскольку у них отсутствует ядерная мембрана. Известные примеры доядерных организмов — бактерии и синие морские водоросли.

Организмы, относящиеся к ядерным, или эукариотам, имеют оформленное ядро, отделенное от остальной среды клетки ядерной мембраной, так что их ДНК постоянно находится в ядре. В этих организмах процессы генетической транскрипции намного сложнее. Многие гены ядерных организмов составлены из чередующихся частей, названных интронами

’Этот процесс называется трансляцией. — Прим. ред.

34

Глава 1

и экзонами. По завершении этапа транскрипции интроны вырезаются из последовательности иРНК. Это означает, что интроны - участки гена, не используемые в сингезе белка. Распределение интронов и экзонов покажем на примере гена (1082 п. н.) белка натрийуретрического фактора бычьего предсердия: экзоны расположены в позициях 1120, 219-545 и 1071-1082; интроны занимают позиции 121-218 и 546-1070. Таким образом, участки, кодирующие иРНК, содержат только 459 нуклеотидов, и соответствующий белок состоит из 153 остатков. После того как интроны вырезаны, укороченная иРНК, включающая в себя только копии экзонов и регуляторные участки в начале и конце, покидает ядро, поскольку рибосомы находятся в окружающей его цитоплазме10.

Феномен интрона-экзона обусловливает различные названия для обозначения исходной последовательности генов, находящейся в хромосоме, и укороченной последовательности, состоящей только из экзонов. Первую называют геномной ДНК, последнюю комплементарной ДНК или кДНК11. Ученые могут получить кДНК, не зная ее геномную копию. Сначала они захватывают иРНК, вышедшую из ядра и продвигающуюся к рибосомам. Затем, в процессе так называемой обратной транскрипции. они производят молекулы ДНК, используя иРНК в качестве матрицы. Поскольку иРНК содержит только экзоны, проводят также дополнительную сборку синтезированной ДНК. Таким образом, возможно получать молекулы кДНК, не используя генетический материал хромосом.

Как транскрипция, так и обратная транскрипция — сложные процессы, нуждающиеся в участии ферментов. Транскриптаза и обратная транскриптаза, или ревертаза, ферменты, катализирующие эти процессы в клетке. Известен также феномен альтернативного сращивания. Он наблюдается, когда, вследствие выборочного сочетания интронов и экзонов, одна и та же геномная ДНК может произвести две или более различных молекул зрелой иРНК. С них в свою очередь синтезируются различные белки.

Теперь возвратимся к синтезу белка и иРНК. В этом процессе очень важные роли играют молекулы РНК двух других видов. Как уже было упомянуто, процесс синтеза белка протекает в клеточных структурах, называс мых рибосомами. Рибосомы построены из белков, прикрепленных к каркасу из специфического вида РНК, получившей название рибосомной РНК, или рРНК12. Рибосома функционирует подобно сборочной линии, на «вход»

10Этот процесс называется сращиванием, или сплайсингом. Прим. ред.

11 Эта молекула называется зрелой иРНК, в отличие от пред-иРНК (иРНК-пре тшест-венннка), которая была транскрибирована, но не сплайсирована. При», ред.

12Скорее, рибосомы построены из РНК и сравнительно небольшого количества белка. — Прим. ред.

1.4. МЕХАНИЗМЫ МОЛЕКУЛЯРНОЙ ГЕНЕТИКИ

35

которой подается молекула иРНК, а также молекулы РНК другого вида (транспортной РНК, или тРНК), а с «выхода» снимается готовая полипеп-тидная цепь.

Репликация

Обратная транскрипция

Рис. 1.9. Передача генетической информации в клетке: так называемая «Центральная догма молекулярной биологии»

Именно молекулы транспортной РНК фактически включают генетический код в процесс, называемый трансляцией. Они обеспечивают связь между кодоном и кодируемой им определенной аминокислотой. На одной стороне каждой молекулы тРНК находится структура, имеющая высокую степень сродства с определенным кодоном, а на другой стороне - структура, которая легко связывается с соответствующей аминокислотой13. Когда информационная РНК продвигается через внутреннюю часть рибосомы, тРНК распознает текущий кодон — кодон в иРНК, находящийся в данное время внутри рибосомы, комплементарно связывается с ним. принося с собой соответствующую аминокислоту («вблизи» активной рибосомы всегда имеется богатый запас аминокислот). В этот момент трехмерное положение всех этих молекул таково, что, как только тРНК связывается со своим кодоном, прикрепленная к ней аминокислота оказывается в непосредственной близости с предыдущей аминокислотой в формируемой полипептидной цепи. Тогда специальный фермент катализирует присоединение новой аминокислоты к белковой цепи и освобождает се от тРНК14. В ходе данного процесса полипептидная цепь последовательно наращивается остаток за остатком. Когда появляется стоп-кодон, ему не соответствует никакая тРНК н синтез прекращается. Информационная РНК освобождается и расщепляется клеточными механизмами до рибонуклеотидов, которые в свое время будут повторно использованы для синтеза новой молекулы РНК.

1 *Э1 о делают специальные белки аминоацил-тРИК-синтетаэы. Именно они устанавливают еоо1вететвие антикодон«-*аминокислота. Прим. ред.

’’Удивительно, но роль этого фермента исполняет рРНК, а не белок! Прим. ред.

36

ГЛАВА 1

На первый взгляд может показаться, что существует столько же видов молекул тРНК, сколько кодонов, но это не верно. Фактическое число молекул тРНК варьирует у разных видов организмов. Например, бактерия Е. coli имеет приблизительно 40 видов тРНК. Некоторые кодоны не представлены молекулами тРНК, а некоторые виды тРНК могут связывать более одного кодона.

На рис. 1.9 только что описанные нами процессы показаны в виде блок-схемы. Как правило, выражение «Центральная догма» используется для обозначения нашего современного, синтетического представления о передаче генетической информации в клетках.

1.4.3. ИЗБЫТОЧНАЯ ДНК И РАМКИ СЧИТЫВАНИЯ

Здесь мы осветим некоторые дополнительные детали процессов, описанных в предыдущих разделах.

Ранее было сказано, что гены — это определенные непрерывные и смежные участки хромосомы; однако они не покрывают всю молекулу целиком. Каждый отдельный ген (или же группа сцепленных генов) с обеих сторон окружен регуляторными участками, роль которых заключается в управлении транскрипцией гена и другими связанными с ней процессами, тогда как функции всех прочих межгенных участков до сих пор не известны. Их называют избыточной или некодирующей ДНК, потому что они, по-видимому, находятся там без какой-либо конкретной цели. Более того, эти участки накапливают мутации, поскольку изменение, не затрагивающее гены или их регуляторные участки, часто оказывается не смертельным и поэтому передается потомству.

Однако недавние исследования показали, что избыточная ДНК имеет больше информационного содержания, чем полагали ранее. Количество избыточной ДНК варьирует у разных видов. Прокариоты, как правило, имеют совсем немного таких участков — их хромосомы почти полностью покрыты генами. Напротив, у эукариотов много избыточной ДНК. Хромосомы человека, по оценкам специалистов, на 90 % состоят из некодирующей ДНК.

Еще одна деталь, относящаяся к процессу транскрипции, которую следует знать, — понятие рамки считывания. Рамка считывания — это один из трех возможных способов группировки оснований при формировании кодонов в последовательности РНК или ДНК. Например, рассмотрим последовательность

TAATCGAATGGGC.

1.4. МЕХАНИЗМЫ МОЛЕКУЛЯРНОЙ ГЕНЕТИКИ 37

Одна рамка считывания может быть представлена кодонами ТАА, TCG, ААТ и GGG, не включая последнее основание С. Другая рамка считывания игнорирует первое основание Т и формирует кодоны ААТ, CGA, ATG и GGC. Еще одна рамка считывания дала бы кодоны АТС, GAA и TGG, не учитывая два основания в начале (ТА) и два основания в конце (GC).

Заметим, что эти три рамки считывания начинаются, соответственно, в позициях 1, 2 и 3 данной последовательности. Если бы мы должны были рассмотреть рамку считывания, начинающуюся в позиции 4, то полученные кодоны были бы поднабором кодонов для стартовой позиции 1, так что мы бы получили фактически ту же самую рамку считывания, но только начинающуюся с другой позиции. Вообще, если мы выбираем стартовые позиции г и j, где разница j i кратна трем, то мы фактически рассматриваем одну и ту же рамку считывания.

Иногда мы говорим не о трех, а о шести различных рамках считывания в последовательности. В этом случае мы рассматриваем последовательность ДНК и притом учитываем обе нити. Тогда получается: три рамки считывания в одной нити и другие три — в комплементарной нити, что дает общее количество шесть рамок. Обычно так поступают, когда исследуют недавно расшифрованную молекулу ДНК и хотят сравнить се с последовательностью белка из базы данных. Сначала нужно транслировать последовательность ДНК в последовательность белка, но для этого существует шесть способов, в каждом из которых необходимо выбрать новую рамку считывания. Тот факт, что мы теряем одно или два основания на концах последовательности, не важен; эти последовательности достаточно длинные, чтобы обеспечить достоверное сравнение, невзирая на несколько отсутствующих остатков.

Открытой рамкой считывания, или ОРС последовательности ДНК называют непрерывный участок этой последовательности, начинающийся в стартовом кодоне и включающий в себя целое число кодонов (его длина кратна трем), причем ни один из его кодонов не является стоп-кодоном. Дополнительные регулирующие участки, расположенные выше стартового кодона, также используются, чтобы характеризовать ОРС.

1.4.4. ХРОМОСОМЫ

В этом разделе мы кратко опишем процесс передачи генетической информации на уровне хромосом. Сначала мы отметим, что полный набор хромосом в клетке называют геномом. Число хромосом в геноме организма характеризует его принадлежность к определенному виду. Например, каждая клетка человека содержит 46 хромосом, тогда как у мышей это чис

38

ГЛАВА 1

ло равно 40. В табл. 1.3 приведены наборы хромосом и размеры генома некоторых характерных видов.

Таблица 1.3. Размер генома определенных видов. Не говоря уже о человеке, пред ставленные здесь организмы чрезвычайно важны для исследований в области молекулярной биологии и генетики

Вид организма Число хромосом (диплоид) Размер генома (п. н.)

Бактериофаг А (вирус) “ 1Т5— 5-Ю4

Escherichia coli (бактерия) I15 5 106

Saccharomyces cerevisiae (дрожжи) 32 1- 107

Caenorhahditis elegans (червь) 12 1 108

Drosophila melanogaster (плодовая мушка) 8 2 - 108

Homo sapiens (человек) 46 3- 109

Прокариоты, как правило, имеют только одну хромосому, которая иногда представляет собой молекулу кольцевой ДНК. Напротив, в клетках эукариотов хромосомы присутствуют в парном виде (по этой причине такие клетки называют диплоидными). Например, геном человека состоит из 23 пар хромосом. Каждый член пары наследуется от каждого родителя. Две хромосомы, формирующие пару, называют гомологичными, и гены в одном члене пары соответствует генам в другом.

Некоторые гены абсолютно идентичны в отцовском и материнском членах пары — например, ген, кодирующий гемоглобин (белок, осуществляющий перенос кислорода в крови). Другие гены могут присутствовать в альтернативных формах, получивших название аллели. Типичный пример данного явления (аллслизма) — ген, кодирующий группу крови людей. Этот ген встречается в трех формах: А, В и О. Как известно, если человек унаследует, скажем, аллель А от матери и аллель В от отца, то он будет иметь группу крови АВ.

Клетки, содержащие только по одному члену из каждой пары хромосом, называют гаплоидны ми. Эти клетки участвуют в половом размножении организмов. Когда гаплоидная клетка матери сливается с гаплоидной клеткой отца, образуется яйцеклетка16, которая снова является диплоидной. Гаплоидные клетки формируются в процессе мейоза, при котором клетка

,5Эти организмы имеют одинарный набор хромосом. Прим, ред

,бЯйцеклеткой называется материнская половая клетка (гаплоидная), а после ее слияния с отцовской половой клеткой образуется оплодотворенная яйцеклетка17. Прим. ред.

1.4. МЕХАНИЗМЫ МОЛЕКУЛЯРНОЙ ГЕНЕТИКИ

39

делится на две и каждая дочерняя клетка получает по одному члену из каждой пары хромосом.

Интересно отметить, что, несмотря на тот факт, что во всех клетках организма присутствует полный набор генов, лишь только малая часть генома обычно используется, или, если употребить биологический термин, экспрессируется любой отдельной клеткой. Например, клетки печени экспрессируют набор генов, отличный от того, который экспрессируют клетки кожи. Механизмы, посредством которых клетки организма дифференцируются на клетки печени, клетки кожи и т.д., все еще во многом не ясны

1.4.5. ПОДОБЕН ЛИ ГЕНОМ КОМПЬЮТЕРНОЙ ПРОГРАММЕ?

После краткого обзора основных механизмов синтеза белка возникает соблазн рассмотреть их в свете так называемой «метафоры генетической программы». Согласно этой метафоре геном организма — это компьютерная программа, полностью определяющая характеристики организма, клеточные механизмы — простые интерпретаторы этой программы, а биологические функции белков — лишь результат механического выполнения команд >той «программы».

Безусловно, метафора выглядит чрезмерно упрощенной, особенно если принять во внимание следующие два факта:

• В реальном процессе транскрипции и трансляции «программа ДНК» подвергается изменениям, так что невозможно узнать, какой белок соответствует данному гену, непосредственно применив генетический код к участку ДНК, кодирующему этот ген

• Экспрессия гена — сложнейший процесс, который может зависеть как от пространственного, так и от временного контекста. Например, нс все гены, присутствующие в геноме, экспрессируются в течение жизни организма, тогда как другие экспрессируются снова и снова; некоторые гены экспрессируются только тогда, когда организм подвергается определенным внешним воздействиям например вирусной инфекции и т. п. Иногда можно наблюдать обратное явление гены, которые экспрессируются в нормальных условиях, могут подавляться под воздействием определенных внешних фак-1оров. Известно, что экспрессия некоторых генов в значительной степени безотносительна, и именно благодаря этому свойству развитие биотехнологии становится возможным. Но это свойство ни в коем случае не верно для всех юнев. Если мы рассматриваем экспрессию гена в клетке как «вычислительный процесс», мы можем сказать, что в случае генома человека

1 Оплодотворенная яйцеклетка (диплоидная) образуется в результате слияния мужской и женской гамет (гаплоидных) и называется зиготой. Прим перев

40

ГЛАВА 1

существует более 1018 таких процессов, происходящих и взаимодействующих одновременно.

Ввиду этих наблюдений, представляется более верным рассматривать организм нс как биологическую систему, абсолютно обусловленную своим геномом, а, скорее, как продукт очень сложной сети одновременных взаимодействий, в которых набор генов является лишь одним из нескольких составляющих факторов.

1.5. МЕТОДЫ ИЗУЧЕНИЯ ГЕНОМА

Первое, на что следует обратить внимание при научном исследовании генома, различный порядок величин, с которыми придется иметь дело. В качестве примера будем рассматривать геном человека. Основная информация, которую мы хотим извлечь из любой части ДНК - послсдо вательность пар нуклеотидов. Процесс получения этой информации называют секвенированием. Человеческая хромосома содержит около 108 п. н. С другой стороны, длина наибольших фрагментов ДНК. которые могут быть секвенированы в лаборатории, составляет всего 700 п. н. Это означает, что между масштабами длин фрагментов, которые мы можем фактически сскве-нировать, и длиной хромосомы существует разрыв приблизительно в 105 порядков. Этот разрыв лежит в основе многих проблем и задач вычислительной биологии; некоторые из них будут рассмотрены в главах 4 (сборка фрагментов) и 5 (составление физических карт). В этом разделе мы кратко опишем несколько лабораторных методов, применение которых сопряжено с трудностями, обусловленными этими проблемами.

1.5.1. КАРТЫ И ПОСЛЕДОВАТЕЛЬНОСТИ

Расположение генов в хромосомах — особенно важный момент, требующий отдельного рассмотрения. Термин локус используют для обозначения местоположения гена в хромосоме (иногда — как синоним слова ген). Самый простой вопрос, возникающий в этом контексте: если рассматривать два гена, — принадлежат ли они одной или разным гомологичным парам? На него можно ответить, не обращаясь к молекулярным методам, поскольку в данном вопросе подразумеваются гены, затрагивающие видимые признаки организма, — например, цвет глаз или форма крыльев. Требуется всего лишь проверить, наследуются ли эти признаки совместно или независимо. Мы скажем, что они наследуются или, более профессионально, — что они распределяются, или расщепляются независимо, если вероятность того, что потомство унаследует от одного родителя оба признака, прибли

1.5. МЕТОДЫ ИЗУЧЕНИЯ ГЕНОМА

41

жённо равна 50 %. Если признаки распределяются независимо, то вполне возможно, что соответствующие гены не сцеплены, то есть скорее всего они принадлежат разным хромосомам. Два гена, принадлежащих одной гомологичной паре, должны распределяться совместно, и тогда потомство, вероятно, унаследует от одного родителя оба признака.

Как это обычно имеет место в биологии, веши не настолько четки: 100 %-е или 50 %-е расщепление признаков встречается далеко не часто. На практике можно наблюдать любой процент распределения генов вследствие кроссинговера. В процессе особого клеточного деления, ведущего к образованию половых клеток, могут появляться новые последовательности генов. В таком случае мы говорим, что происходит рекомбинация генов. Рекомбинация становится возможной, поскольку гомологичные хромосомы перед расхождением могут «перекрещиваться» и обмениваться концевыми фрагментами.

Число возможных вариантов рекомбинации огромно, и на практике мы видим, что частота рекомбинации варьирует в значительной степени. Эти частоты в свою очередь дают информацию о том, как далеко друг от друга в хромосоме расположены исследуемые гены. Если эти гены находятся близко друг к другу, то шанс на расщепление при кроссинговере весьма мал. Если же они отстоят далеко друг от друга, то возможность расщепления возрастает и гены распределяются независимо.

Для составления первых генетических карт изучали последовательные поколения организмов и анализировали наблюдаемые процентные часто-1Ы расщепления исследуемых признаков. Карта сцепления генетических признаков хромосомы представляет собой составленную с использованием подобной информации схему, показывающую порядок и относительное расстояние между генами. Генетические карты полученные на основании частот рекомбинации, безусловно важны, но они имеют два существенных недостатка:

1) они не показывают фактические длины участков хромосомы в парах нуклеотидов или в других линейных единицах;

2) если гены расположены очень близко друг к другу, то нельзя определить их порядок, поскольку при этом вероятность расщепления настолько мала, что наблюдаемые частоты рекомбинации равны нулю.

Карты, которые отражают фактические длины участков в парах нуклео-|идов, называют физическими картами. Для составления физических карт необходимо использовать совершенно иные методы. В частности, мы должны работать с фрагментами ДНК намного меньшей протяженности, чем длина хромосомы, но все еще слишком большими для их непосредственной расшифровки. Физическая карта может указать положение маркеров,

42

Глава 1

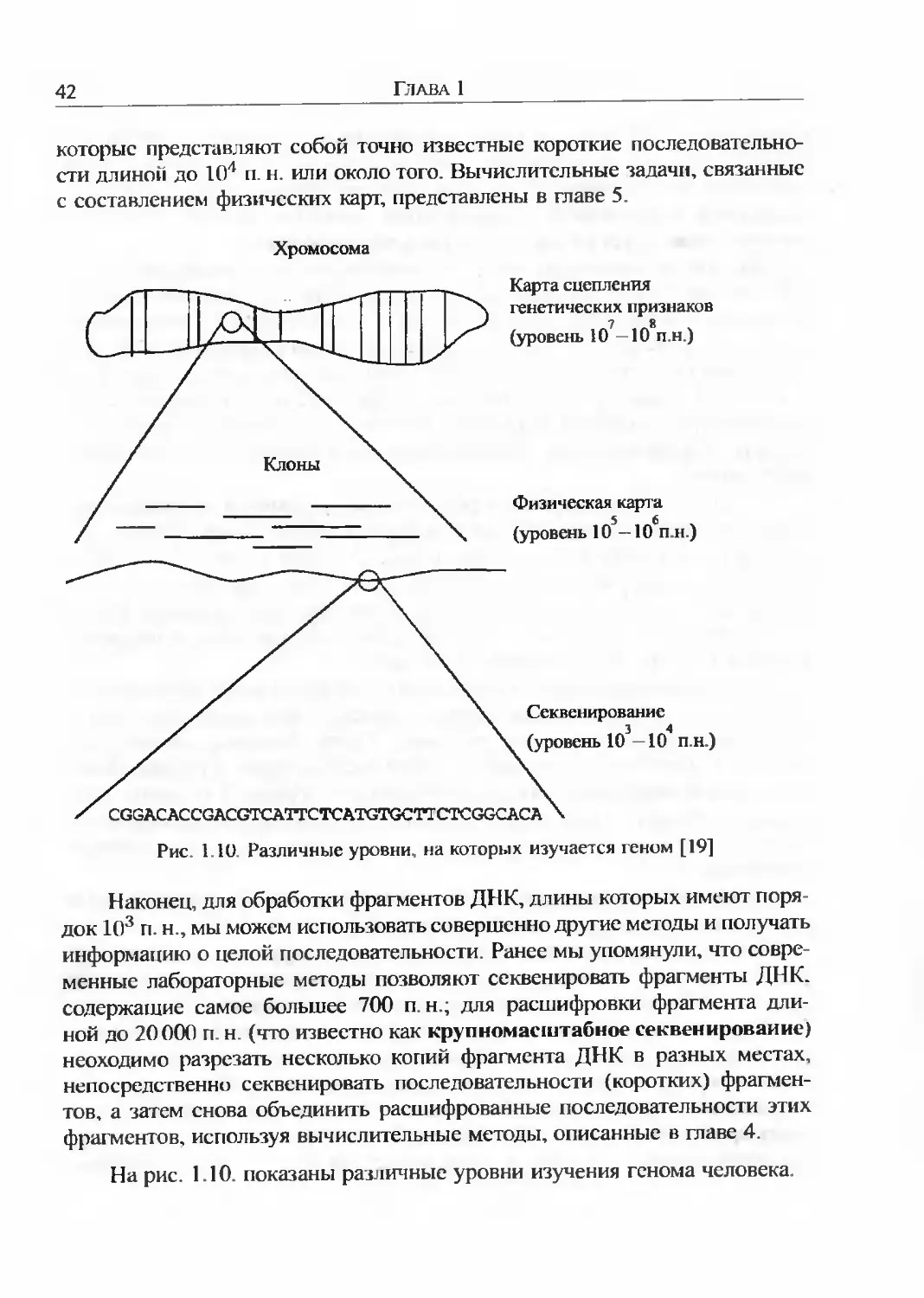

которые представляют собой точно известные короткие последовательности длиной до 104 п. н. или около того. Вычислительные задачи, связанные с составлением физических карт, представлены в главе 5.

Хромосома

Карта сцепления генетических признаков (уровень 10 10 пн)

Клоны

Физическая карта 5 6

(уровень 10—10 п.н.)

Секвенирование

(уровень 10 —10 п.н.)

/ CGGACACCGACGTCATTCTCATGTGCTTCTCGGCACA X

Рис 1.10. Различные уровни, на которых изучается геном [19]

Наконец, для обработки фрагментов ДНК, длины которых имеют порядок 103 п.н., мы можем использовать совершенно другие методы и получать информацию о целой последовательности. Ранее мы упомянули, что современные лабораторные методы позволяют секвенировать фрагменты ДНК. содержащие самое большее 700 п н.; для расшифровки фрагмента длиной до 20000 п. н (что известно как крупномасштабное секвенирование) неоходимо разрезать несколько копий фрагмента ДНК в разных местах, непосредственно секвенировать последовательности (коротких) фрагментов, а затем снова объединить расшифрованные последовательности этих фрагментов, используя вычислительные методы, описанные в главе 4.

На рис. 1.10. показаны различные уровни изучения генома человека.

1.5 МЕТОДЫ ИЗУЧЕНИЯ ГЕНОМА

43

1.5.2. СПЕЦИАЛЬНЫЕ МЕТОДЫ

При составлении физических карт и расшифровке последовательностей необходимо использовать некоторые специальные лабораторные методы. В ном разделе мы приводим краткий обзор таких методов.

Важно понять, что в молекулярной биологии лабораторные меюды почти что всегда производят данные, содержащие ошибки. По этой причине большая часть алгоритмов, разработанных для решения задач вычислительной биологии, применима только в пределах, в которых они могут контролировать ошибки. Данная проблема будет неоднократно подниматься в этой книге.

Вирусы и бактерии

Мы начнем с краткого описания тех организмов, которых наиболее часто используют в генетических исследованиях, то есть с вирусов и бак тсрий.

Вирусы — это паразиты на молекулярном уровне. Едва ли их можно счесть формой жизни, хотя они и могут воспроизводиться при инфицировании подходящих клеток, называемых хозяева ми. Вирусы не проявляют никакого метаболизма: в них не происходят никакие биохимические реакции Вместо этого, для собственной репликации вирусы всецело полагаются на метаболизм хозяина, и именно это их свойство используют в лабораторных экспериментах.

Большинство вирусов состоит из белковой оболочки (капсида), внутри которой содержится генетический материал (ДНК либо РНК) Вирусная ДНК намного меньше ДНК хромосом и поэтому намного больше подходит для всевозможных манипуляций. Когда вирусы заражают клетку, их генетический материал вводится в цитоплазму. Клеточный механизм по ошибке интерпретирует ДНК вируса как свою собственную, и по этой причине клетка начинает производить кодируемые вирусом белки как если бы они были собственными белками клетки. Эти белки активизируют репликацию ви русной ДНК и формирование новых капсидов, так что в зараженной клетке скапливается большое количество вирусных частиц. Затем другие вирусные белки разрушают мембрану клетки и выпускают новые вирусные частицы в окружающую среду, где они могут атаковать следующие клетки.

Некоторые вирусы не убивают хозяев сразу. Вместо этого вирусная ДНК встраивается в геном хозяина и может оставаться там в течение длительного промежутка времени без какого-либо заметного изменения в жизни клетки. При некоторых условиях дремлющий вирус может активизиро

44

Глава 1

ваться, после чего он отделяется от генома хозяина и начинает реплицироваться.

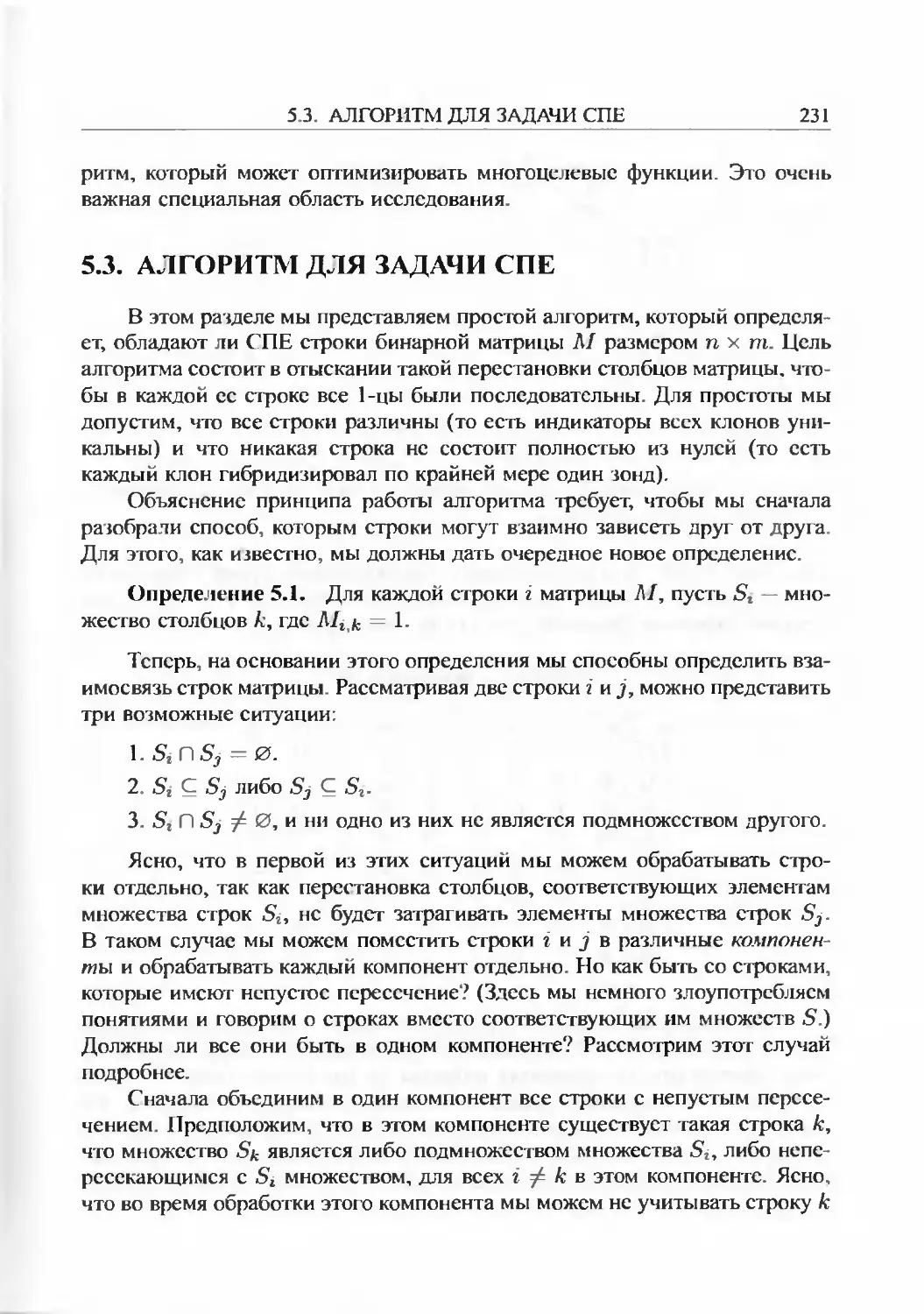

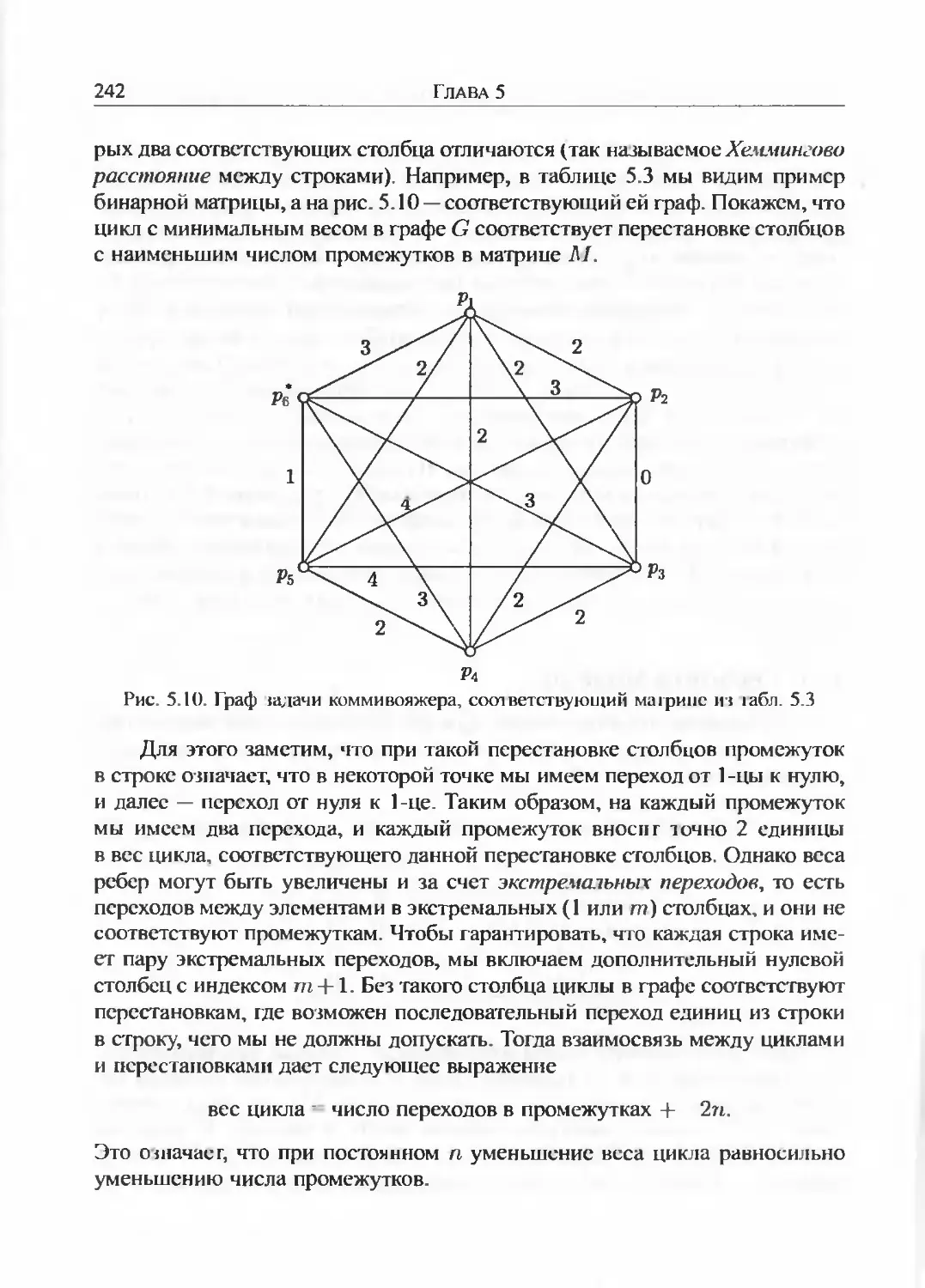

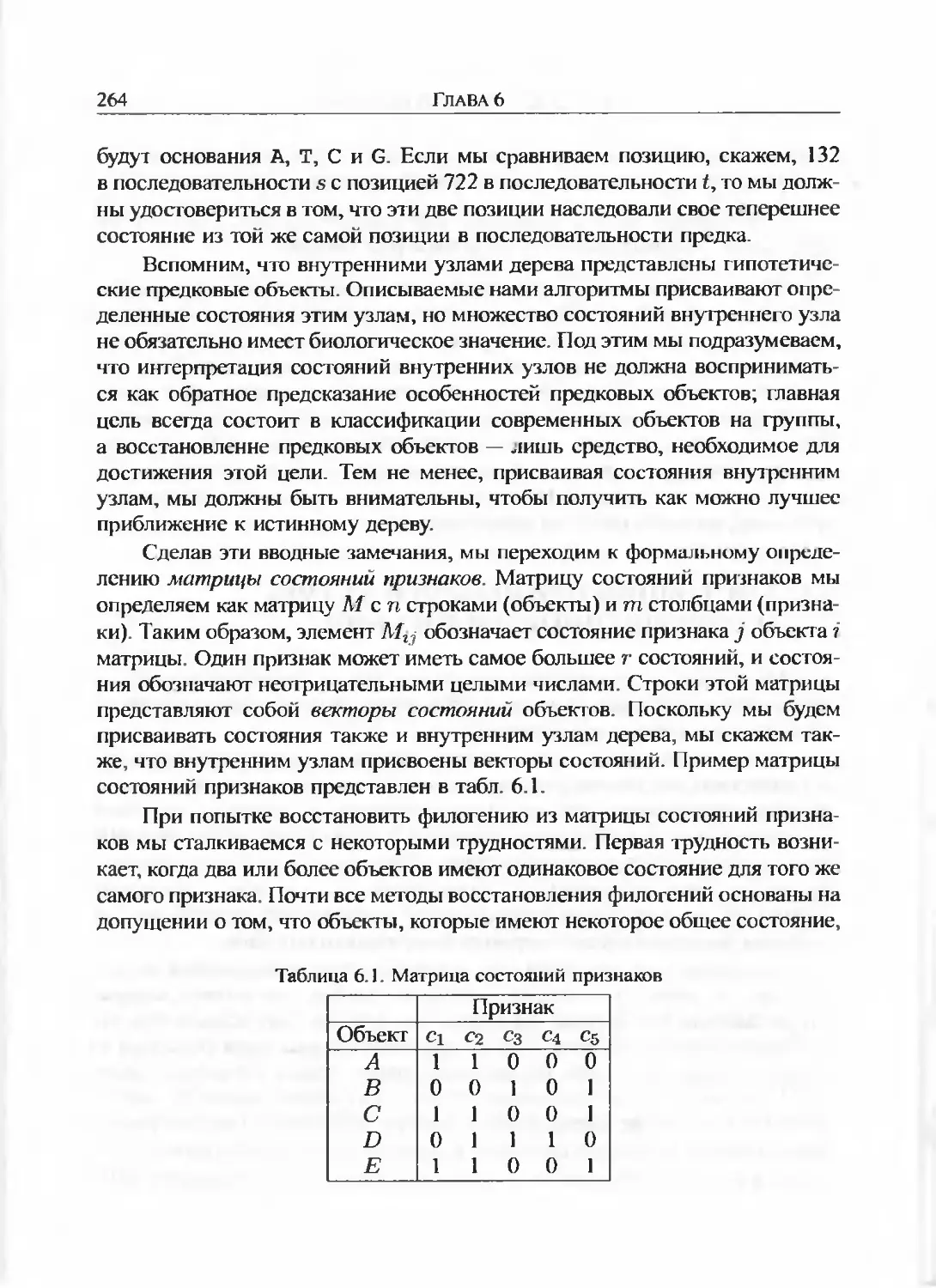

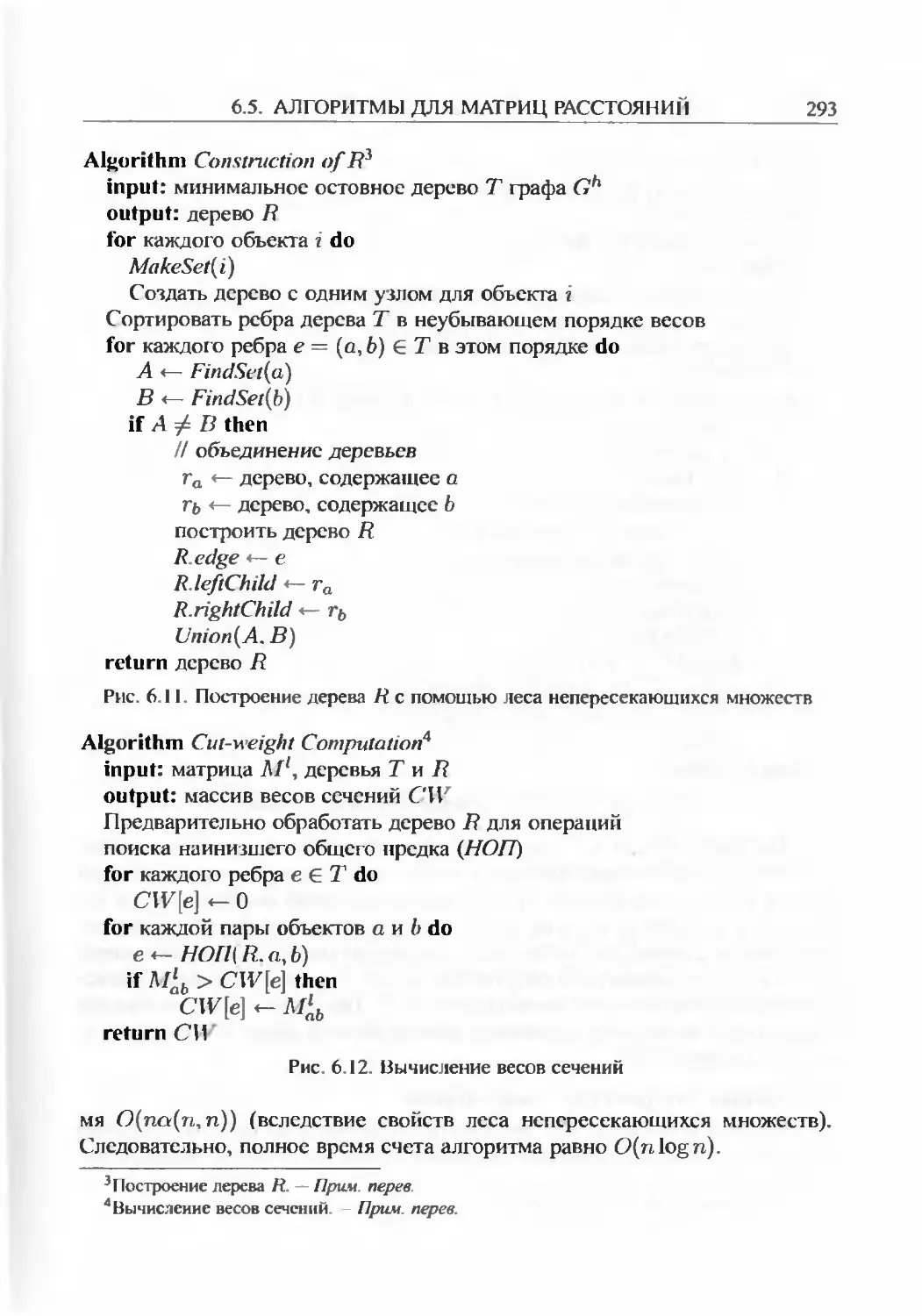

Вирусы чрезвычайно избирательны; они способны инфицировать клетки только определенного вида. Так, например, вирус Т2 заражает только бактерию Е. coli; ВИЧ, вирус иммунодефицита человека, заражает только клетки иммунной системы человека; ВТМ, вирус табачной мозаики, заражает только листья табака. Бактериофаги, или просто фаги, являются вирусами, атакующими бактерии.