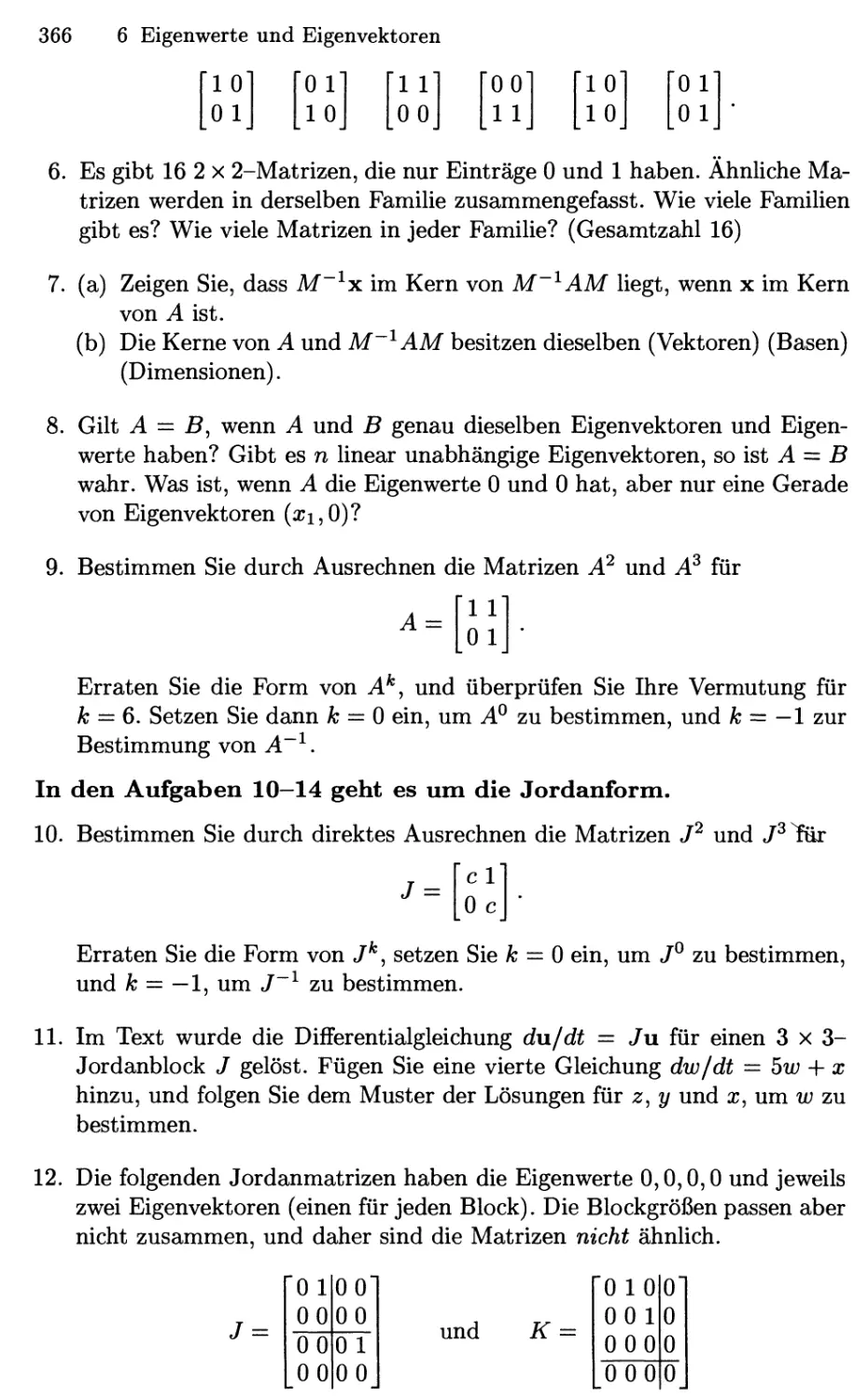

Текст

Gilbert Strang

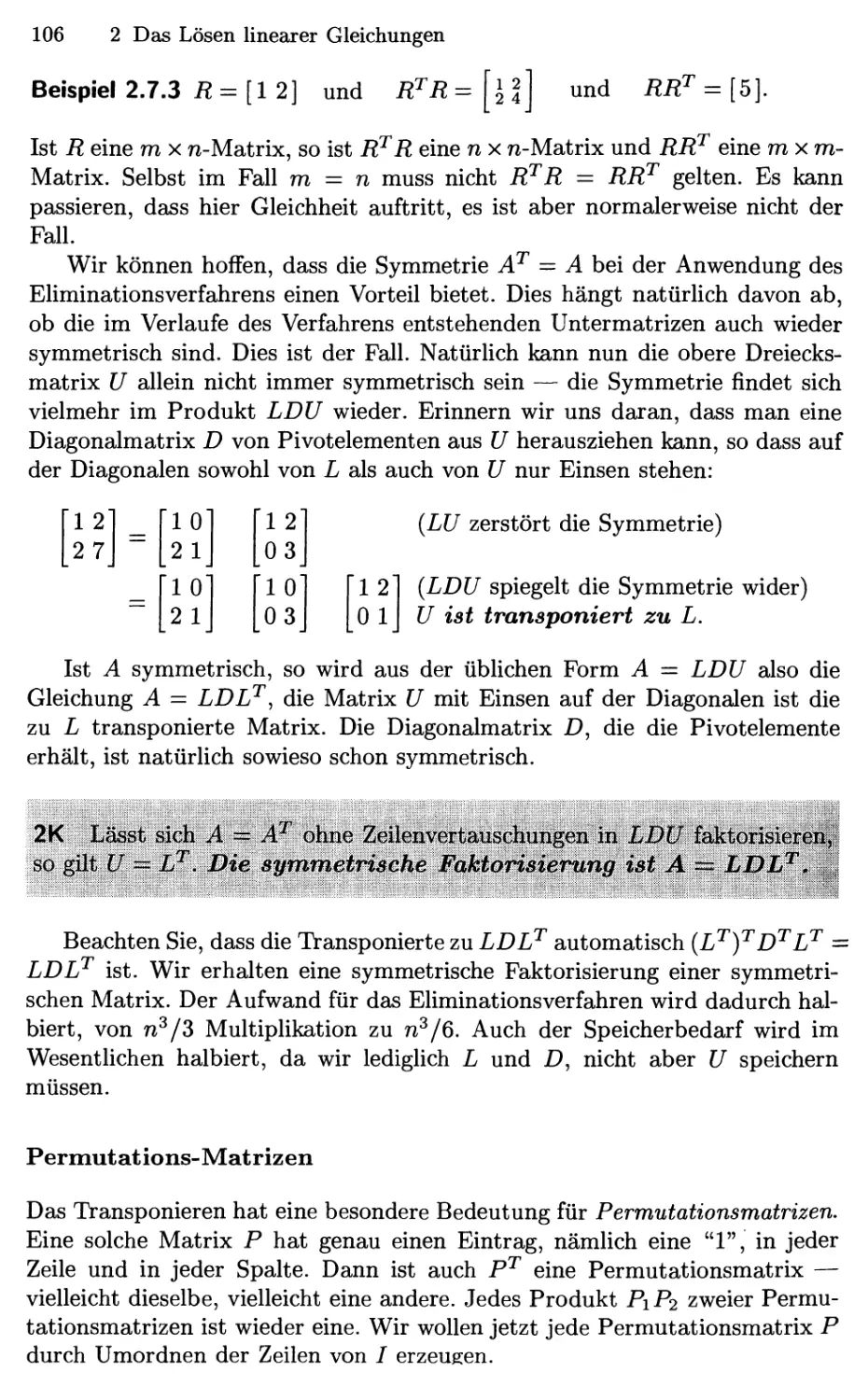

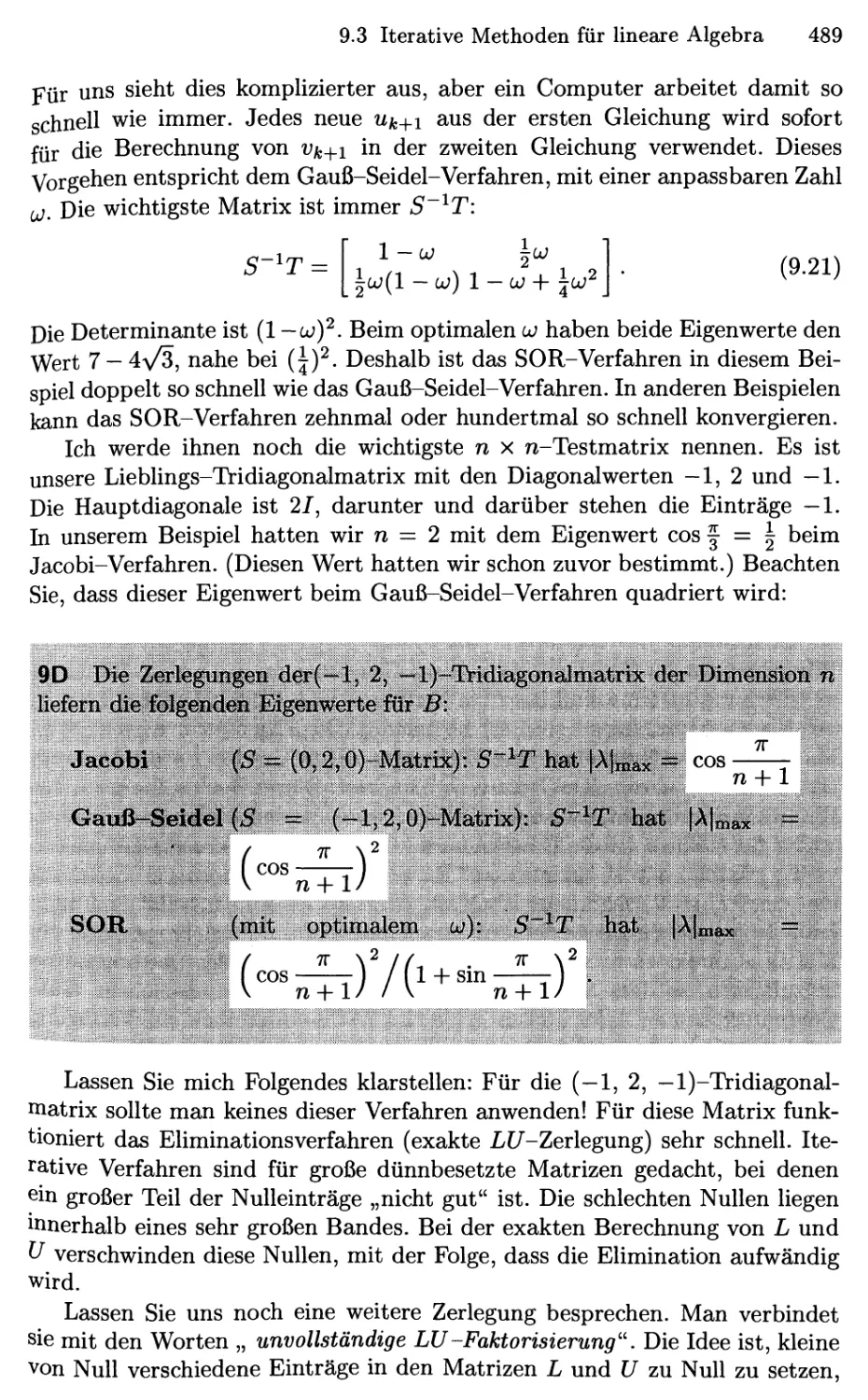

Lineare Algebra

Übersetzt aus dem Englischen von der djs^ GmbH,

unter Mitarbeit von Michael Dellnitz

Springer

Springer

Berlin

Heidelberg

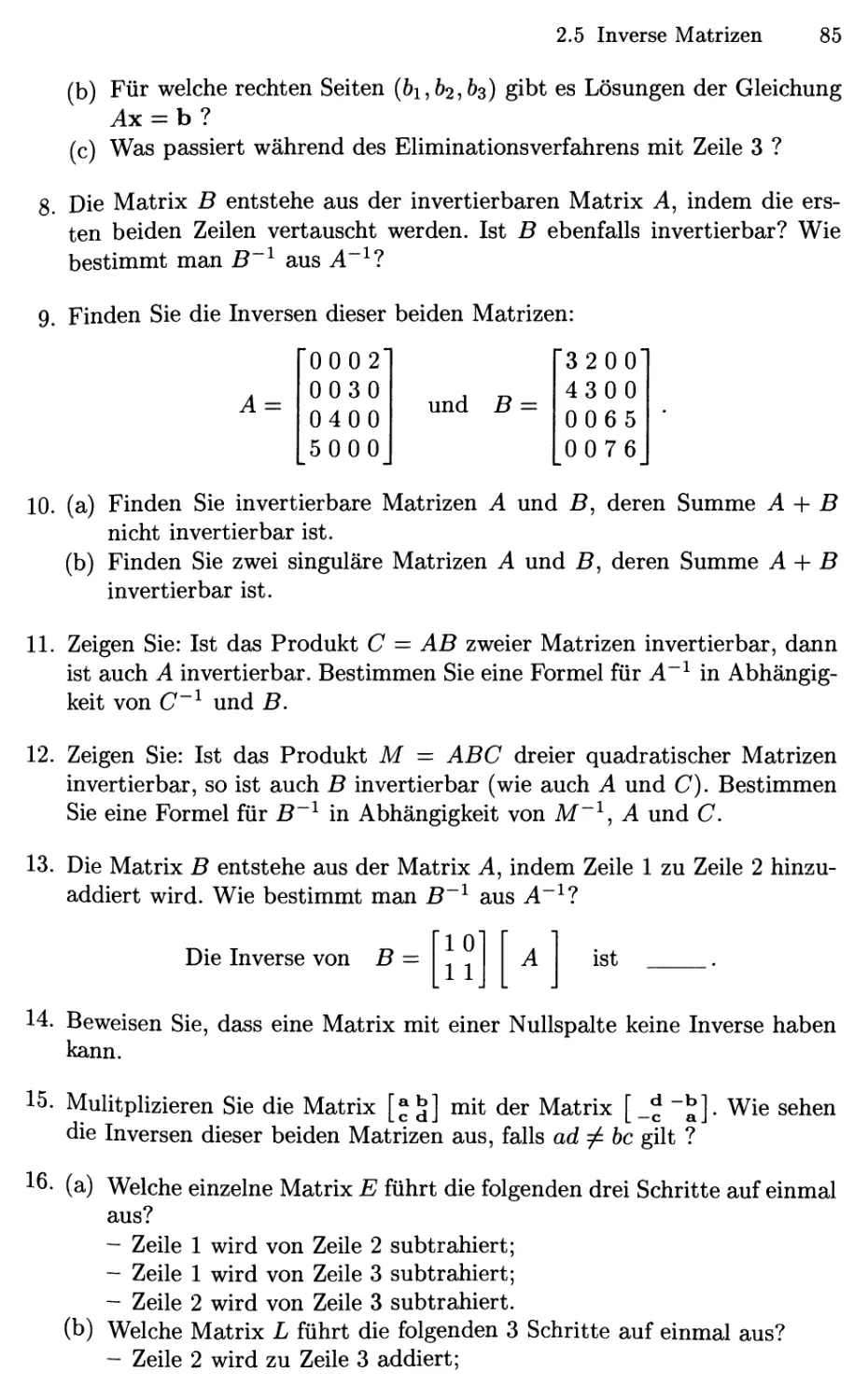

New York

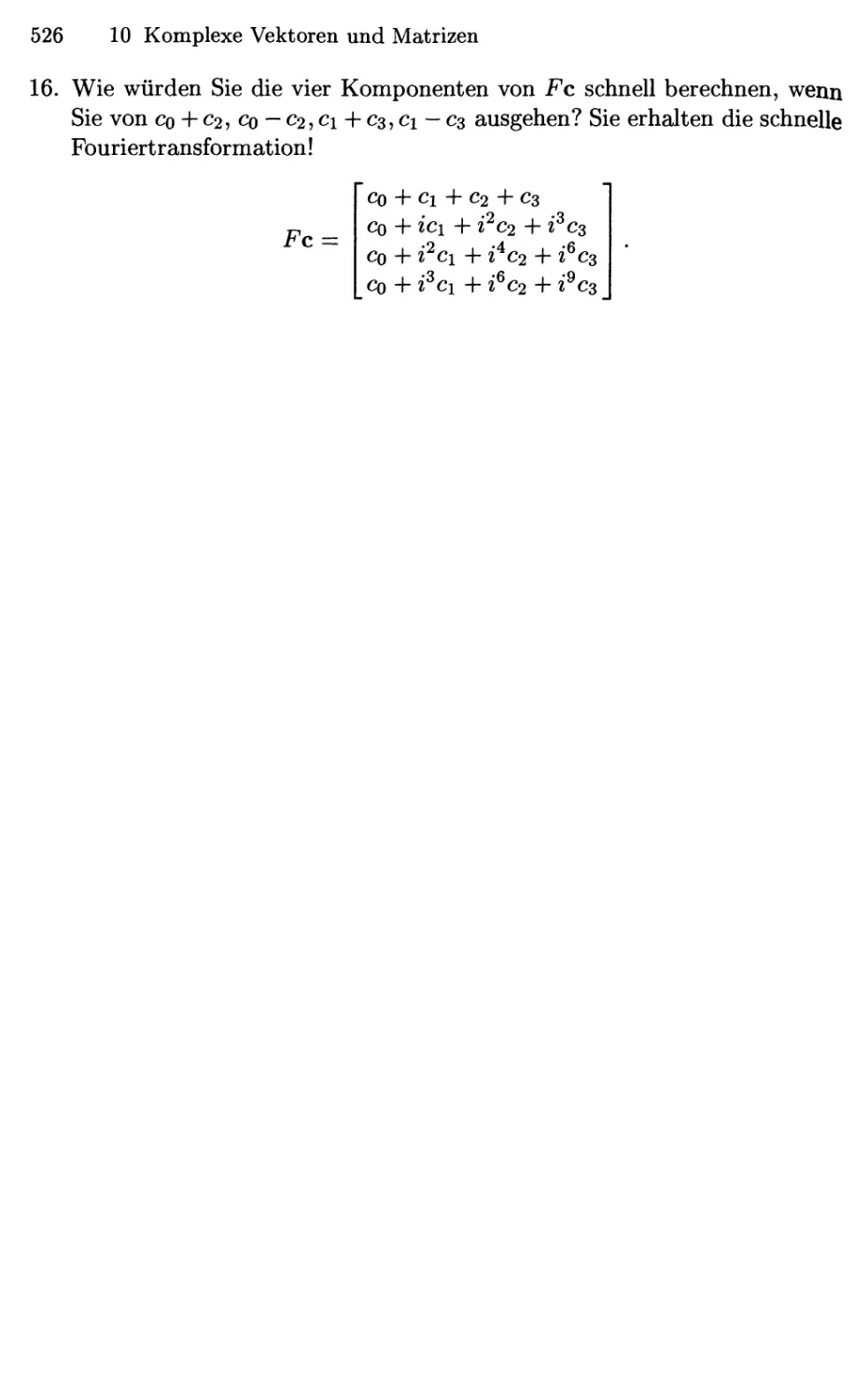

Hongkong

London

Mailand

Paris

Tokio

Professor Gilbert Strang

Massachusetts Institute of Technology

Department of Mathematics

Cambridge, MA 02139-4307

USA

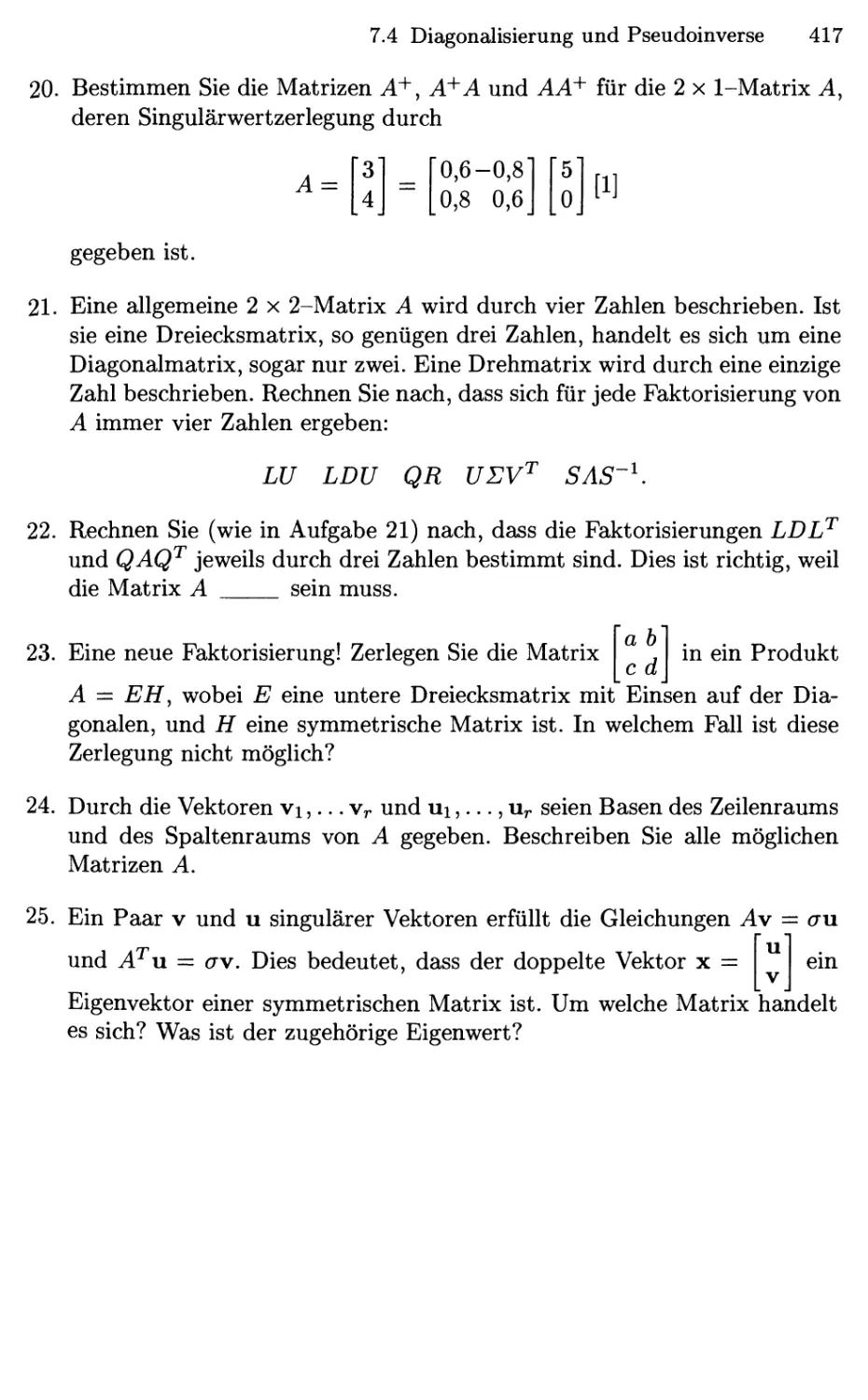

e-mail: gs@math.mit.edu

URL: http://ocw.mit.edu

http://web.mit.edu/i8.o6/www

Übersetzer

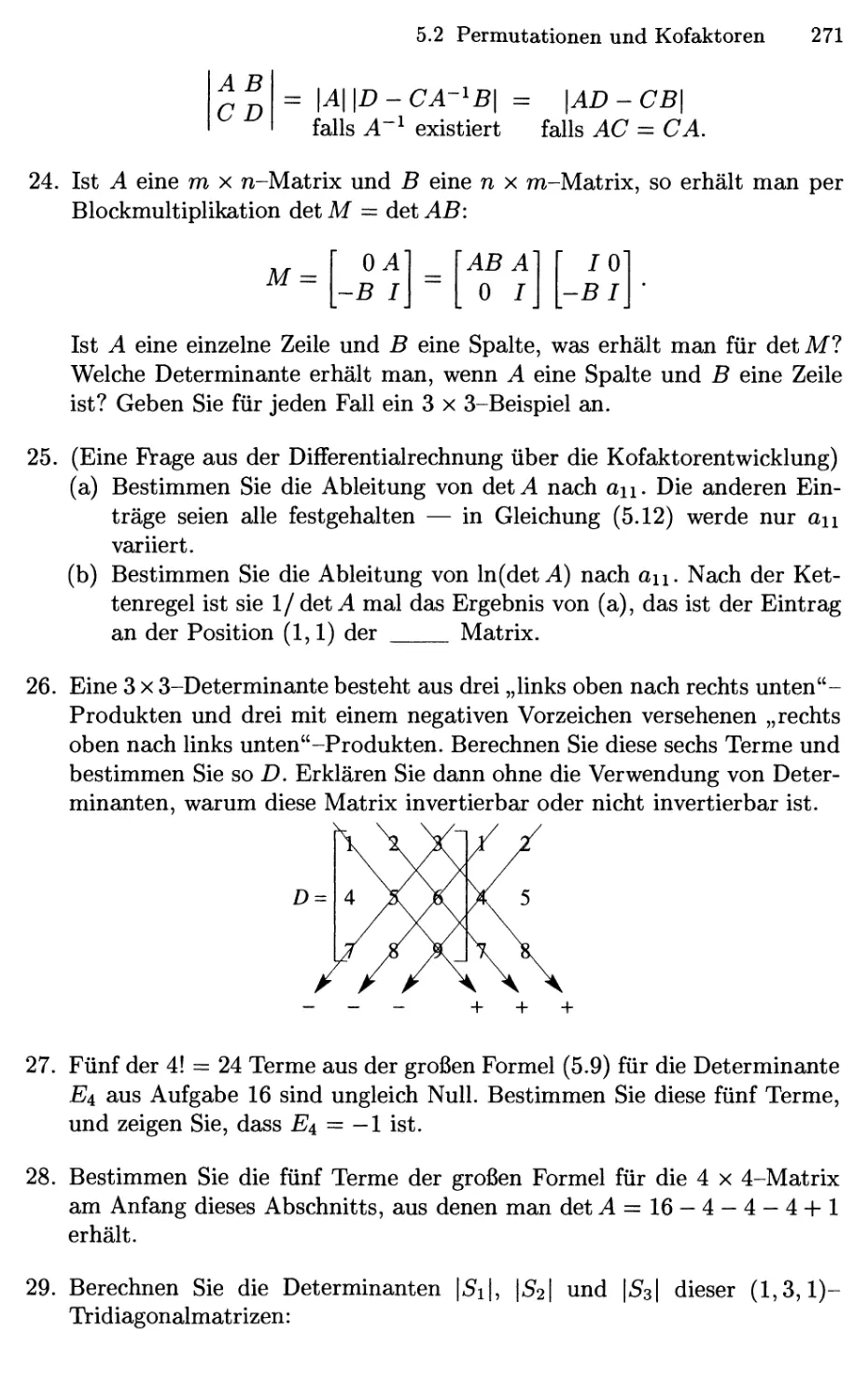

djs2 GmbH

Technologiepark 32

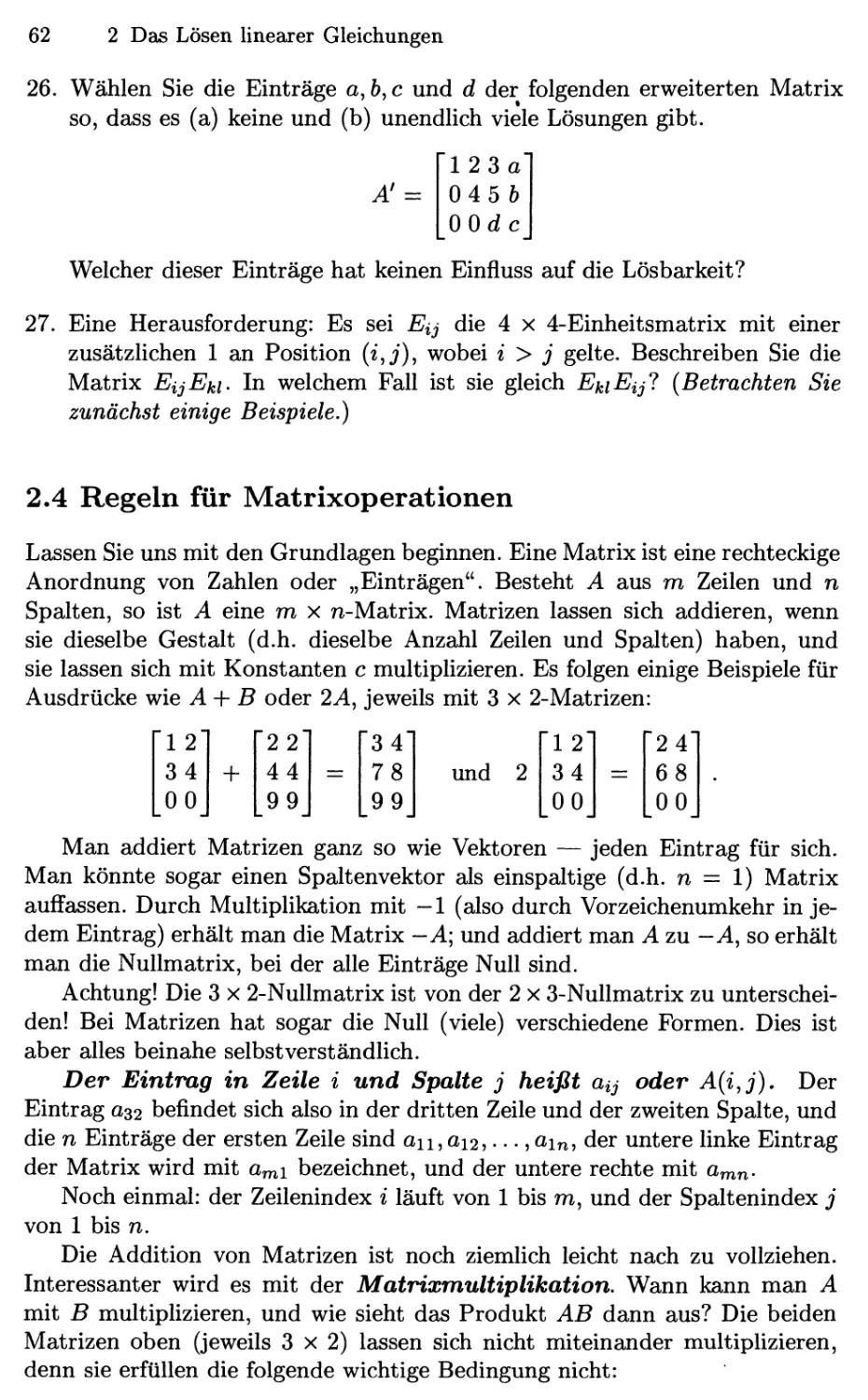

33100 Paderborn

Deutschland

Titel der englischen Originalausgabe: Introduction to Linear Algebra, erschienen bei Wellesley-

Cambridge Press, 1998

Mathematics Subject Classification B000): 15

Bibliografische Information Der Deutschen Bibliothek

Die Deutsche Bibliothek verzeichnet diese Publikation in der Deutschen Nationalbibliografie;

detaillierte bibliografische Daten sind im Internet über <http://dnb.ddb.de> abrufbar.

ISBN 3-540-43949-8 Springer-Verlag Berlin Heidelberg New York

Dieses Werk ist urheberrechtlich geschützt. Die dadurch begründeten Rechte, insbesondere die der Übersetzung, des

Nachdrucks, des Vortrags, der Entnahme von Abbildungen und Tabellen, der Funksendung, der Mikroverfilmung oder

der Vervielfältigung auf anderen Wegen und der Speicherung in Datenverarbeitungsanlagen, bleiben, auch bei nur

auszugsweiser Verwertung, vorbehalten. Eine Vervielfältigung dieses Werkes oder von Teilen dieses Werkes ist auch

im Einzelfall nur in den Grenzen der gesetzlichen Bestimmungen des Urheberrechtsgesetzes der Bundesrepublik

Deutschland vom 9. September 1965 in der jeweils geltenden Fassung zulässig. Sie ist grundsätzlich

vergütungspflichtig. Zuwiderhandlungen unterliegen den Strafbestimmungen des Urheberrechtsgesetzes.

Springer-Verlag Berlin Heidelberg New York

ein Unternehmen der Springer Science+Business Media

http://www.springer.de

© Springer-Verlag BerUn Heidelberg 2003

Printed in Germany

Die Medergabe von Gebrauchsnamen, Handelsnamen, Warenbezeichnungen usw. in diesem Werk berechtigt auch

ohne besondere Kennzeichnung nicht zu der Annahme, daß solche Namen im Sinne der Warenzeichen- und

Markenschutz-Gesetzgebung als frei zu betrachten wären und daher von jedermann benutzt werden dürften.

Satz: Datenerstellung durch den Übersetzer unter Verwendung eines Springer TßX-Makropakets

Einbandgestaltung: design & production GmbH, Heidelberg

Gedruckt auf säurefreiem Papier 46/3iiick - 5 4 3 2 1 SPiN 11319801

Vorwort

Dies ist ein einführendes Lehrbuch zur linearen Algebra, in dem deren Theorie

gemeinsam mit Anwendungen dargestellt wird. Die zentralen Gegenstände

sind lineare Gleichungssysteme Ax = b und das Eigenwertproblem Ax = Xx.

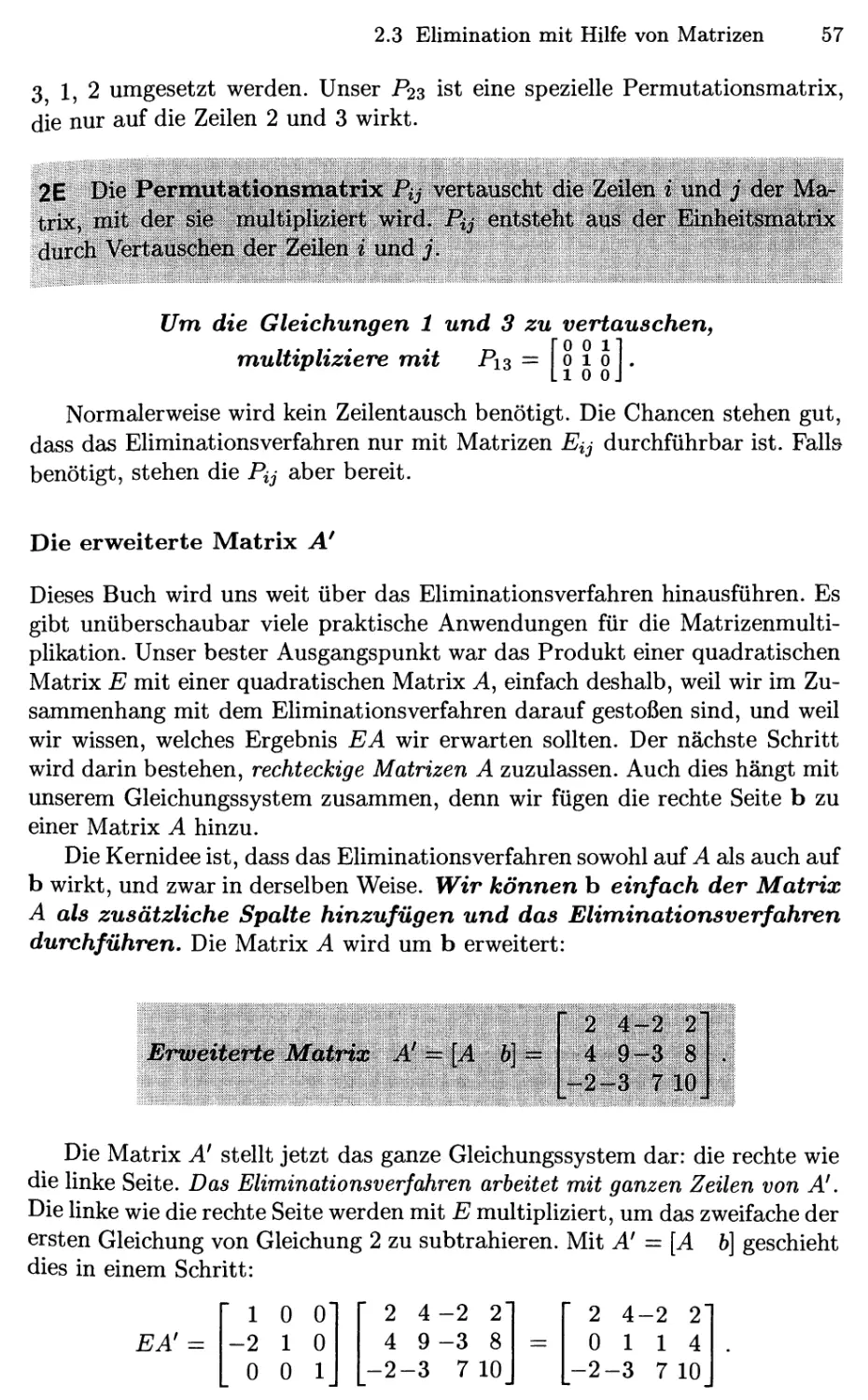

Es ist einfach verblüffend, wie viel es zu diesen beiden Gleichungen zu sagen

(und zu lernen) gibt. Dieses Buch ist als das Resultat jahrelangen Lehrens,

Organisierens und Nachdenkens über den Kurs zur linearen Algebra zu sehen

— und doch kommt mir das Thema immer wieder neu und sehr lebendig vor.

Ich bin wirklich froh darüber, dass die lineare Algebra weithin als wichtige

Disziplin anerkannt ist. Sie ist definitiv ebenso wichtig wie die

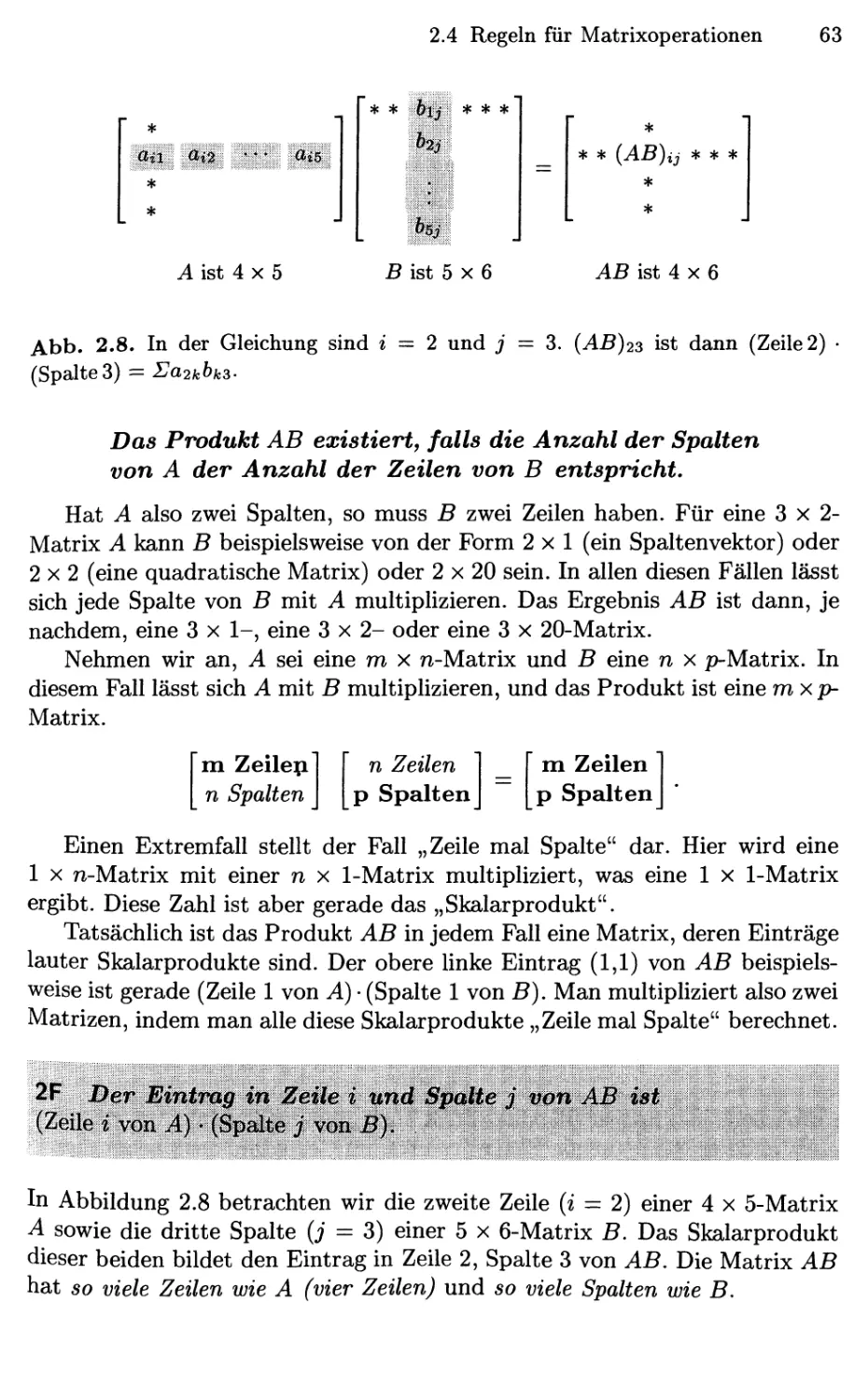

Differentialrechnung. Hier werde ich um nichts nachgeben, insbesondere wenn ich mir

ansehe, wie Mathematik tatsächlich angewendet wird. So viele der

aktuellen Anwendungen sind diskreter statt kontinuierlicher Natur, digital anstatt

analog, linearisierbar anstatt erratisch und chaotisch. In diesen Fällen sind

Vektoren und Matrizen die mathematische Beschreibung der Wahl.

In der Gleichung Ax = b werden diese Begriffe direkt verwendet. Auf

der linken Seite finden wir eine Matrix A und einen unbekannten Vektor

X. Ihr Produkt Ax ist eine Kombination der Spalten von A. Hierin

besteht die beste Sichtweise, die Multiplikation zu betrachten; die Gleichung

fragt nach derjenigen Kombination, die den Vektor b erzeugt. Wir können

die Lösung auf drei Beschreibungsebenen finden, die alle sehr wichtig sind:

1. Direkte Lösung durch Vorwärtseliminieren und Rücksubstitution.

2. Matrix-Lösung durch x = A~^h unter Verwendung der inversen

Matrix A~'^.

3. Vektorraum-Lösung durch Bestimmung aller Linearkombinationen

der Spalten von A und aller Lösungen der Gleichung Ax = 0. Wir

betrachten hierbei den Spaltenraum und den Kern.

Es gibt noch eine weitere Möglichkeit: Es könnte sein, dass die Gleichung

Ax = h keine Lösung hat Der direkte Weg über das Eliminationsverfahren

kann auf eine Gleichung der Form 0 == 1 führen. Der Weg über die Matrix A~^

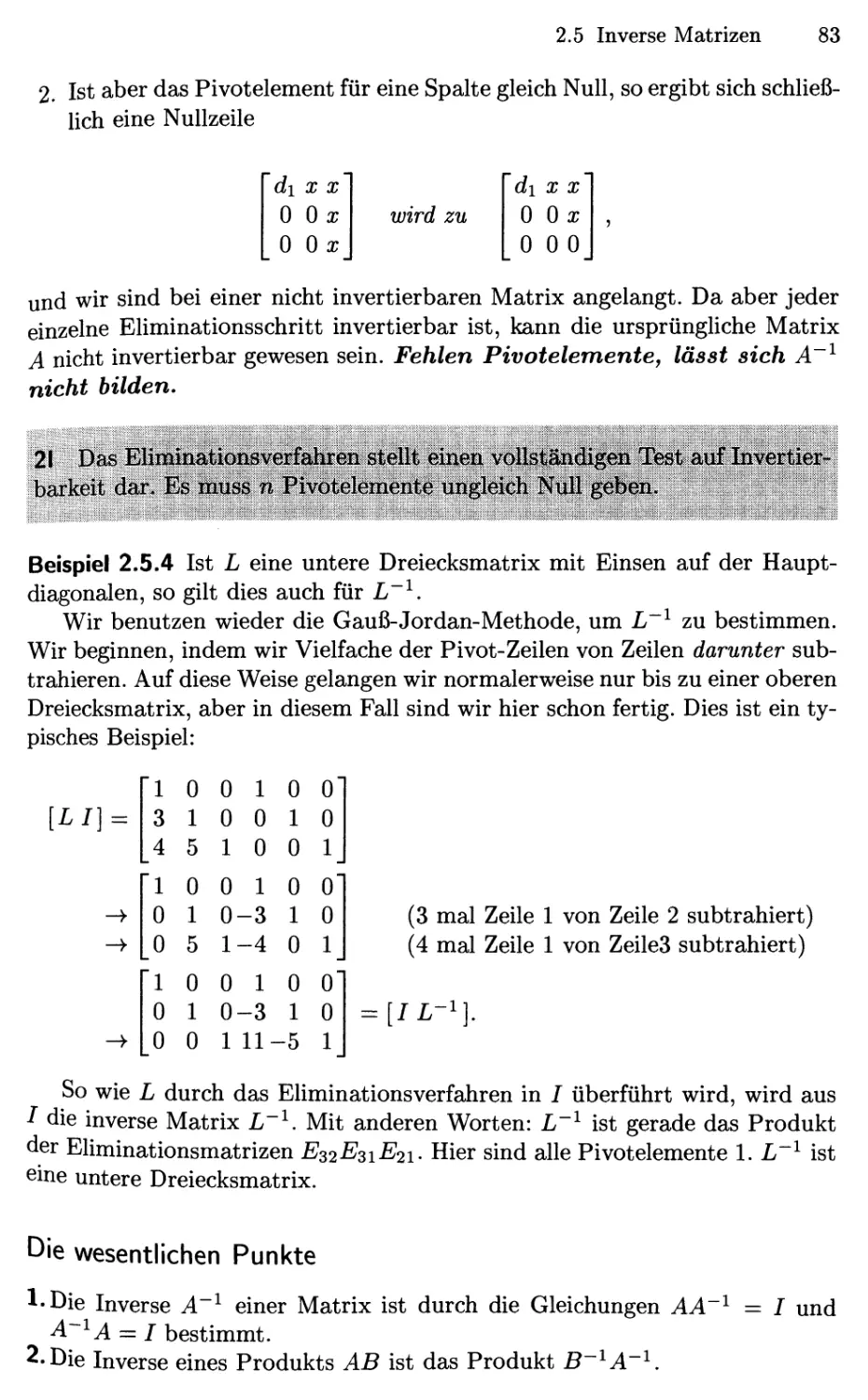

kann fehlschlagen, weil diese Matrix nicht bestimmt werden kann. Auf dem

Weg über die Vektorräume betrachtet man alle Kombinationen der Spalten.

Es kann aber sein, dass b nicht in diesem Spaltenraum liegt. Ein Teil der

Mathematik wird helfen zu verstehen, unter welchen Umständen eine Gleichung

lösbar ist und wann nicht.

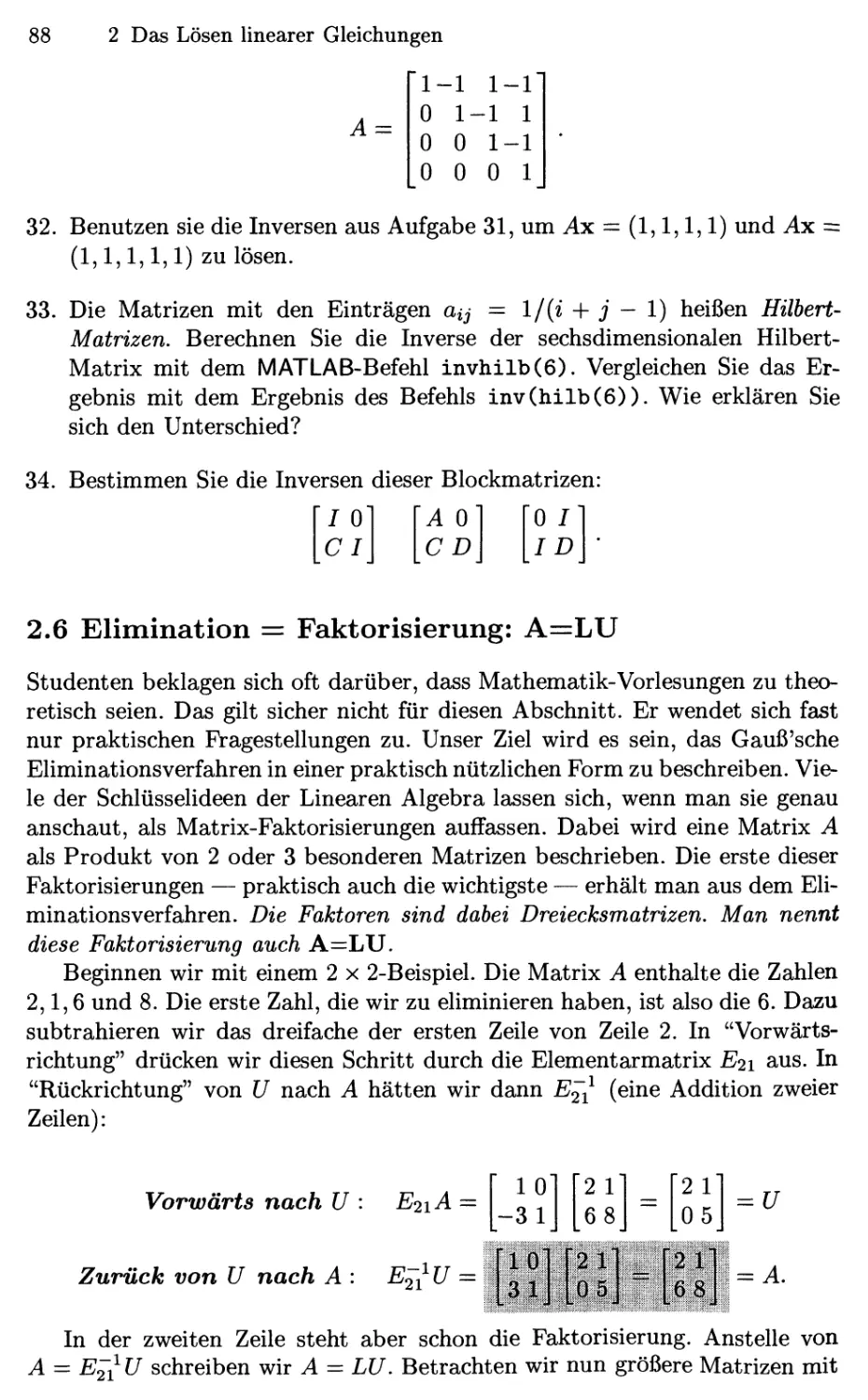

VI Vorwort

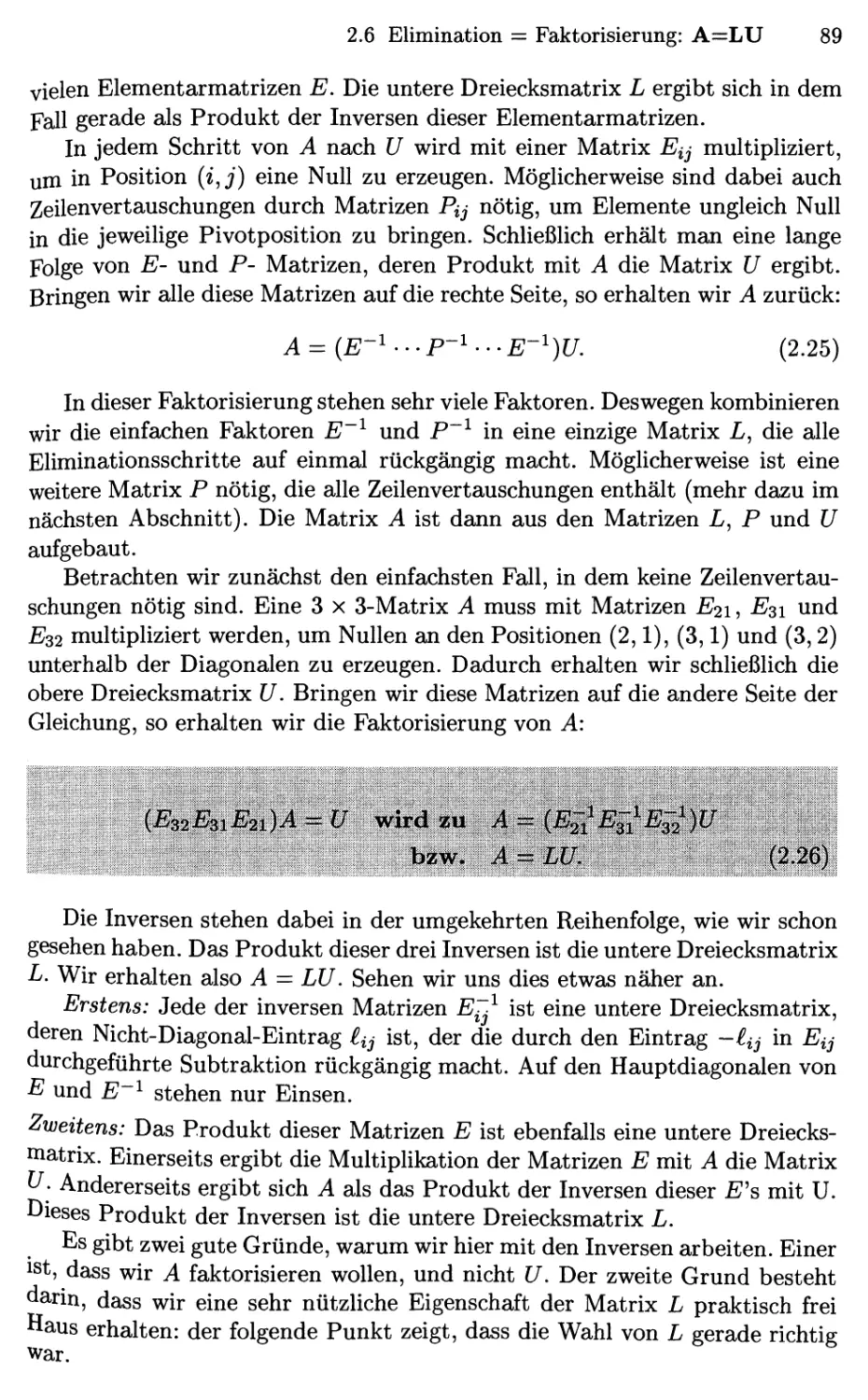

Ein weiterer Teil besteht darin, Vektoren zu visualisieren. Bei einem

Vektor V mit zwei Komponenten ist das nicht schwierig. Dessen Komponenten vi

und V2 geben an, wie weit man zur Seite und nach oben gehen muss — damit

können wir einen Pfeil zeichnen. Ein zweiter Vektor w könnte zum Beispiel

rechtwinklig zu v sein (in Kapitel 1 lernen Sie, wann genau). Haben die

Vektoren jedoch sechs Komponenten, so können wir sie nicht länger zeichnen,

obwohl wir in unserer Vorstellung genau dies weiter versuchen. Wir können

uns sogar im sechsdimensionalen Raum einen rechten Winkel vorstellen. Wir

können auch 2v (doppelt so lang) und — w (in die w entgegengesetzte

Richtung) sehen. Wir können uns beinahe Kombinationen wie 2v—w vorstellen.

Am Wichtigsten ist das Bemühen, sich alle Kombinationen von cv

und dw vorzustellen. Diese Kombinationen erzeugen eine Art

„zweidimensionaler Ebene" innerhalb des sechsdimensionalen Raums. Während ich diese

Worte schreibe, bin ich mir überhaupt nicht sicher, ob ich diesen Unterraum

sehen kann. Die lineare Algebra bietet aber eine einfache Möglichkeit, mit

Vektoren und Matrizen jeglicher Größe zu arbeiten. Haben wir es mit sechs

Strömen in einem Netzwerk oder mit sechs Kräften auf eine Struktur zu tun,

oder mit sechs Preisen für unsere Produkte, so befinden wir uns sicherlich in

einem sechsdimensionalen Raum. Für die lineare Algebra ist ein sechsdimen-

sionaler Raum noch verhältnismäßig klein.

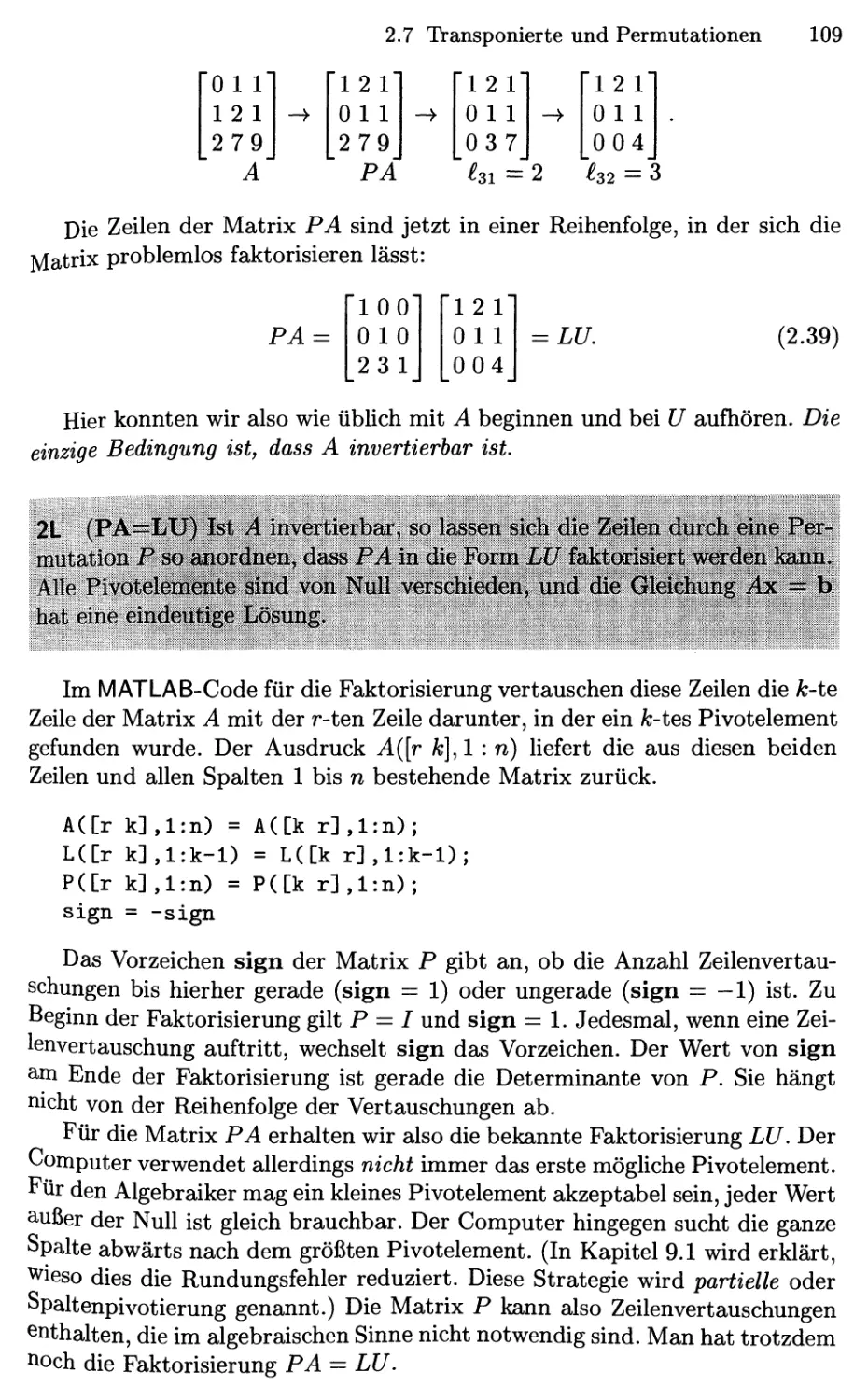

Sie erkennen an diesem Vorwort bereits den Stil dieses Buches und seine

Zielsetzung. Es ist im Stil informell, in seiner Zielsetzung aber absolut

ernsthaft. Bei der linearen Algebra handelt es sich um großartige Mathematik, die

ich so klar wie möglich zu erklären versuche. Ich hoffe, dass der Professor,

der diesen Kurs unterrichtet, dabei etwas Neues lernt. Der Autor tut dies

jedes mal. Studierende werden bemerken, dass in den Anwendungen die Ideen

nochmals verdeutlicht werden. Dies ist der Hauptpunkt für uns alle: zu

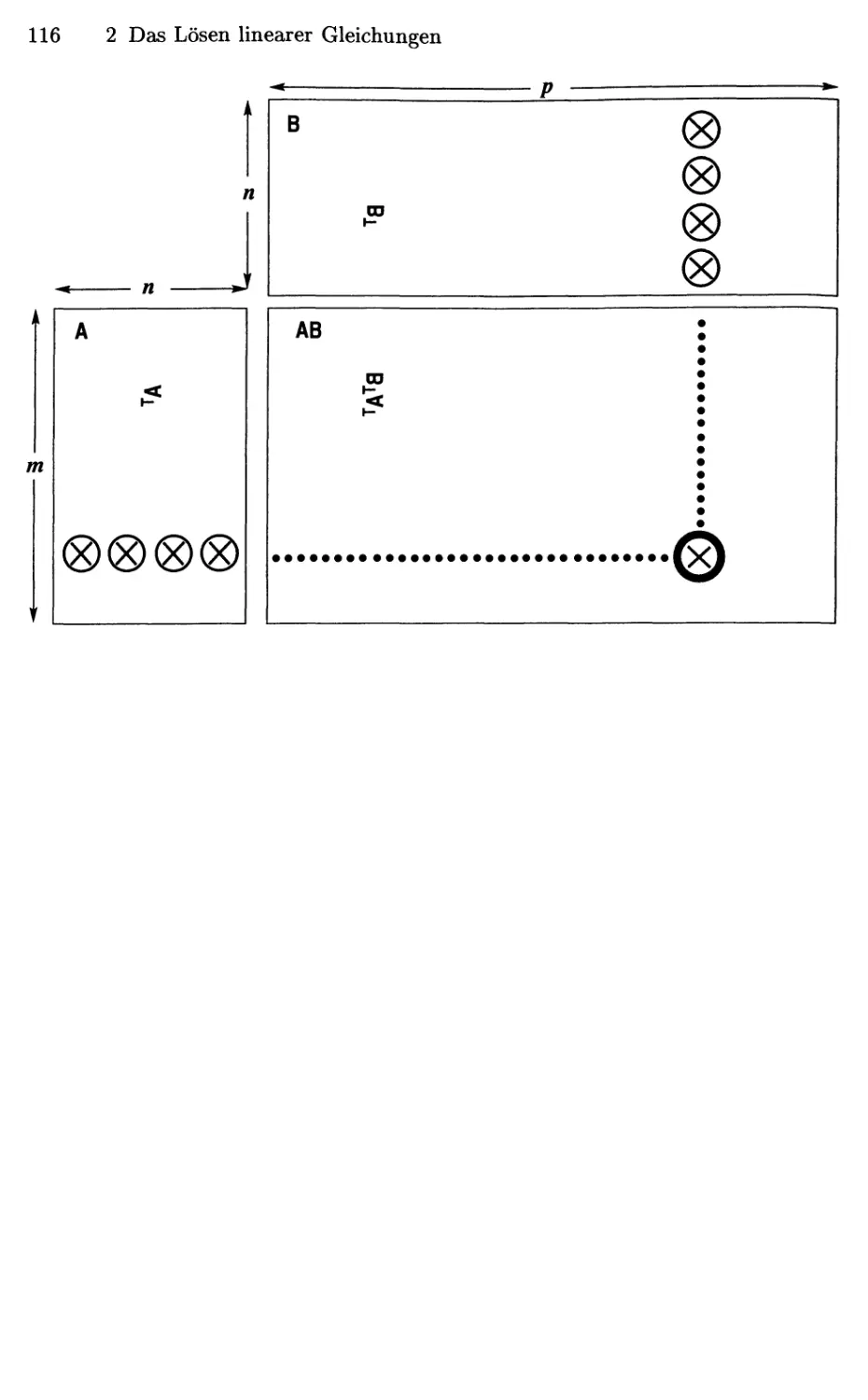

Lernen, wie man denkt. Ich hoffe, sie erkennen, wie dieses Buch voranschreitet,

schrittweise^ aber unaufhaltsam.

In der Mathematik wird man ständig dazu angehalten, über den Einzelfall

hinauszublicken und das allgemeine Prinzip zu erkennen. Ob wir es mit Pixel-

Intensitäten auf einem Fernsehschirm zu tun haben oder mit Kräften auf ein

Flugzeug, oder auch mit den Flugplänen für die Piloten, immer haben wir

es mit Vektoren zu tun, die mit Matrizen multipliziert werden. Es lohnt sich

also, die lineare Algebra gut zu studieren.

Die Struktur des Lehrbuchs

Ich möchte fünf Anmerkungen zum Aufbau dieses Buchs machen:

1. Kapitel 1 bietet eine kurze Einführung in die wesentlichen Ideen hinter

Vektoren, Matrizen und Skalarprodukten. Wenn der Kurs mit diesen

Begriffen bereits vertraut ist, stellt es kein Problem dar, direkt mit Kapitel 2

zu beginnen, in dem die Lösung eines n x n-Gleichungssystems ^x = b

behandelt wird.

Vorwort VII

2. Ich verwende die reduzierte Zeilen-Treppenform für rechteckige Matrizen

nun häufiger als zuvor. In MATLAB erhält man sie über das

Kommando i? = rref (A). Durch die Reduktion von A auf R erhält man Basen

des Zeilen- und des Spaltenraums. Darüber hinaus liefert die Reduktion

der erweiterten Matrix [AI] die vollständige Information über alle vier

fundamentalen Unterräume.

3. Diese vier Unterräume bieten eine wunderbare Möglichkeit, die Begriffe

lineare Unabhängigkeit, Dimension und Basis zu verstehen. Diese Beispiele

sind so natürlich und ganz ungezwungen der Schlüssel zu den

Anwendungen. Ich möchte mir keine Vektorräume ausdenken, wo es doch so viele

wichtige gibt, die man wirklich braucht. Hat der Kurs erst zahlreiche

Beispiele zur Unabhängigkeit und Abhängigkeit von Vektoren gesehen,

so wird die Definition praktisch im Voraus verstanden. Die Spalten einer

Matrix A sind unabhängig, wenn x = 0 die einzige Lösung der Gleichung

Ax = 0 ist.

4. In Abschnitt 6.1 werden Eigenwerte für 2 x 2-Matrizen eingeführt. Oft

besteht der Wunsch, Eigenwerte früh zu behandeln (um sie für andere

Fächer verfügbar zu machen, oder um zu vermeiden, dass sie ganz

ausgelassen werden). Deshalb ist es kein Problem, von Kapitel 3 direkt in den

Abschnitt 6.1 zu springen. Für eine 2 x 2-Matrix ist die Determinante

sehr einfach, und das Konzept der Eigenwerte wird klar erkennbar.

5. Jeder Abschnitt der Kapitel 1 bis 7 endet mit einer hervorgehobenen

Wiederholung der Wesentlichen Punkte. Der Leser erhält damit die

Möglichkeit, den Inhalt des Textes zu rekapitulieren, indem er diese Wiederholung

sorgfältig durchgeht.

Ein einsemestriger Kurs, der ununterbrochen voranschreitet, kann bis zu den

Eigenwerten gelangen. Die Hauptidee besteht darin, eine Matrix zu diagona-

lisieren. Für die meisten quadratischen Matrizen erhält man dabei die Fakto-

risierung S~^AS mit der Eigenvektormatrix S. Für symmetrische Matrizen

erhält man Q^AQ. Ist A eine allgemeine rechteckige Matrix, so benötigen

wir die Form JJ-^AV. Ich versuche, die Singulärwertzerlegung so gut ich kann

zu erklären, weil sie extrem nützlich geworden ist. Ich habe bei diesem Kurs

und seiner Aufnahme durch die Studierenden ein sehr gutes Gefühl.

Struktur des Kurses

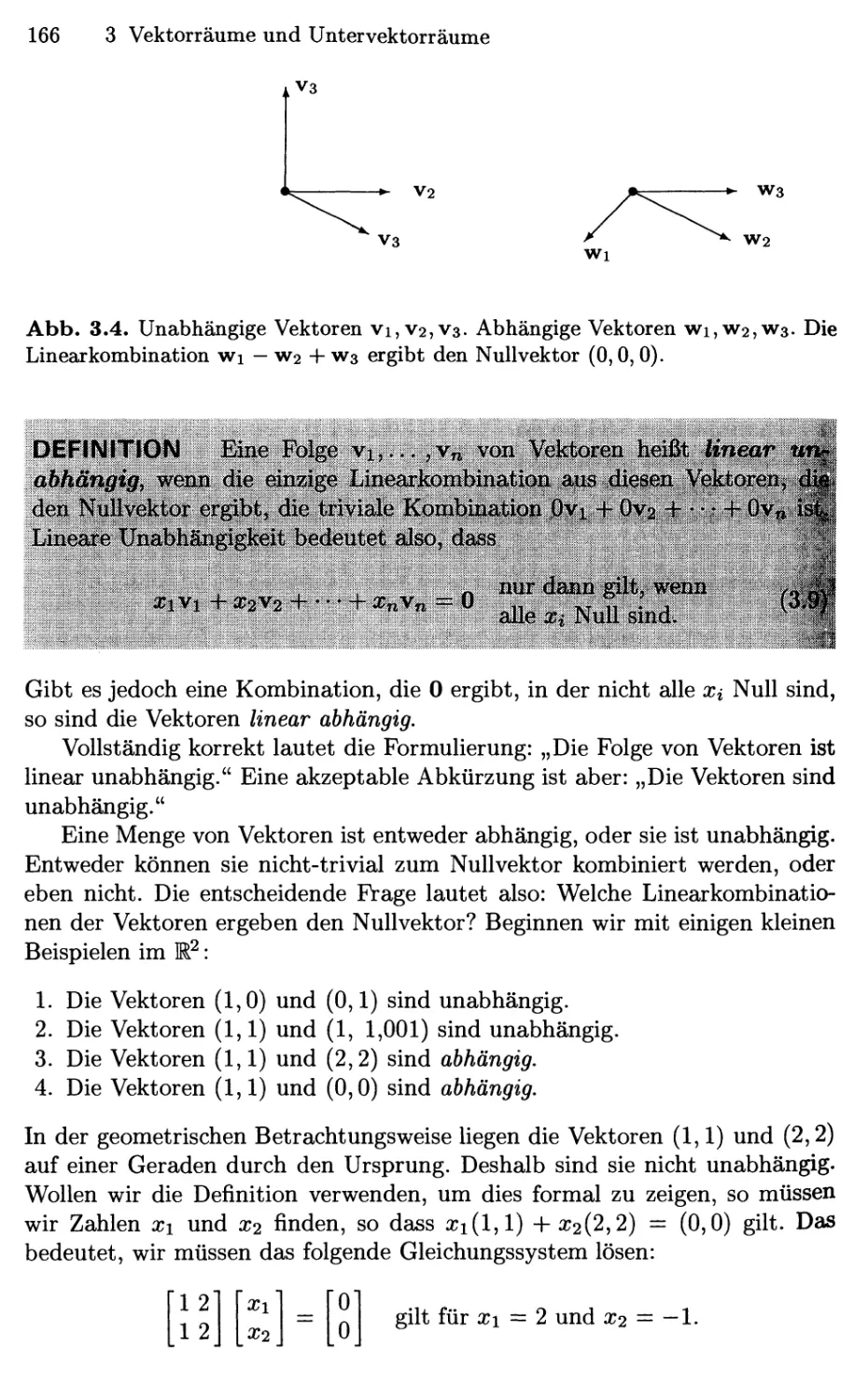

Die Kapitel 1-6 enthalten das Herzstück eines einführenden Kurses zur

linearen Algebra — die Theorie sowie auch Anwendungen. Die Schönheit äußert

sich in der Weise, in der diese beiden Teile ineinander verzahnt sind. Die

Theorie wird benötigt und Anwendungen finden sich überall.

Mittlerweile verwende ich eine Webseite, um den Inhalt, Hausaufgaben

und Lösungen zu Klausuren zu veröffentlichen:

http://web.init.edu/18.06/www

VIII Vorwort

Ich hoffe, Sie finden diese Seite nützlich. Sie hat fast 30.000 Besucher gehabt.

Machen Sie regen Gebrauch davon, und geben Sie mir Anregungen, aufweiche

Weise man sie noch verbessern und erweitern kann.

In Kapitel 7 wird erklärt, wie Matrizen mit linearen Abbildungen

zusammenhängen. Die Matrix hängt von der Wahl einer Basis ab! Wir zeigen, wie

sich Vektoren und Matrizen ändern, wenn die Basis gewechselt wird, und wir

zeigen auch die lineare Abbildung, die hinter der Matrix steht. Ich beginne

den Kurs nicht mit dieser (tiefer liegenden) Idee, weil es besser ist, zunächst

Unterräume zu verstehen.

In Kapitel 8 werden wichtige Anwendungen präsentiert — ich wähle oft

die Markov-Matrizen für eine Vorlesung ohne Klausur. In Kapitel 9 wenden

wir die Aufmerksamkeit wieder der numerischen linearen Algebra zu, und

erklären, wie die Gleichungen Ax = b und Ax = Ax tatsächlich gelöst

werden. In Kapitel 10 machen wir den Schritt von reellen zu komplexen Zahlen

als Einträge in Matrizen und Vektoren. Das ganze Buch ist für einen zweise-

mestrigen Kurs angemessen — es beginnt schrittweise und geht immer weiter

voran.

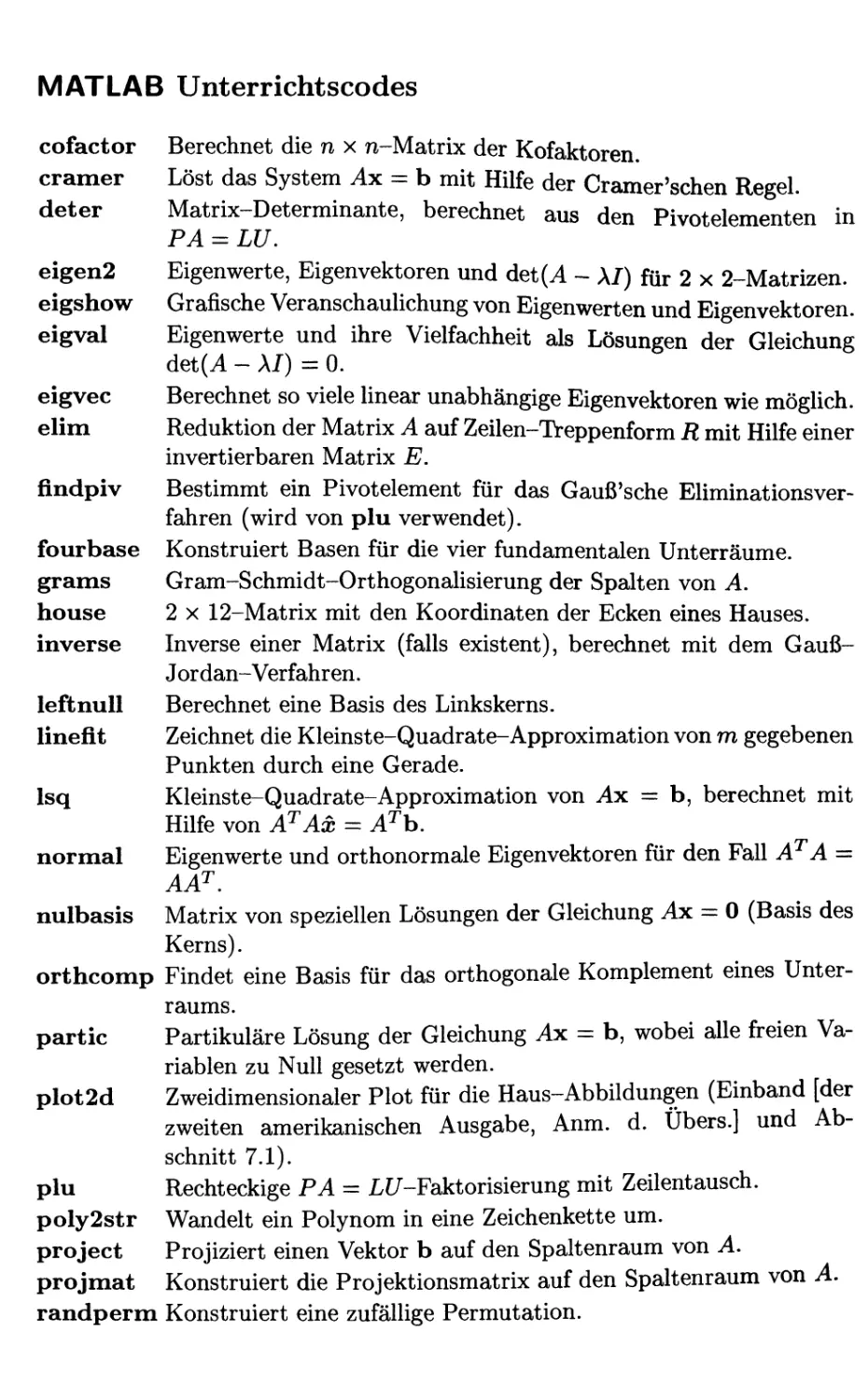

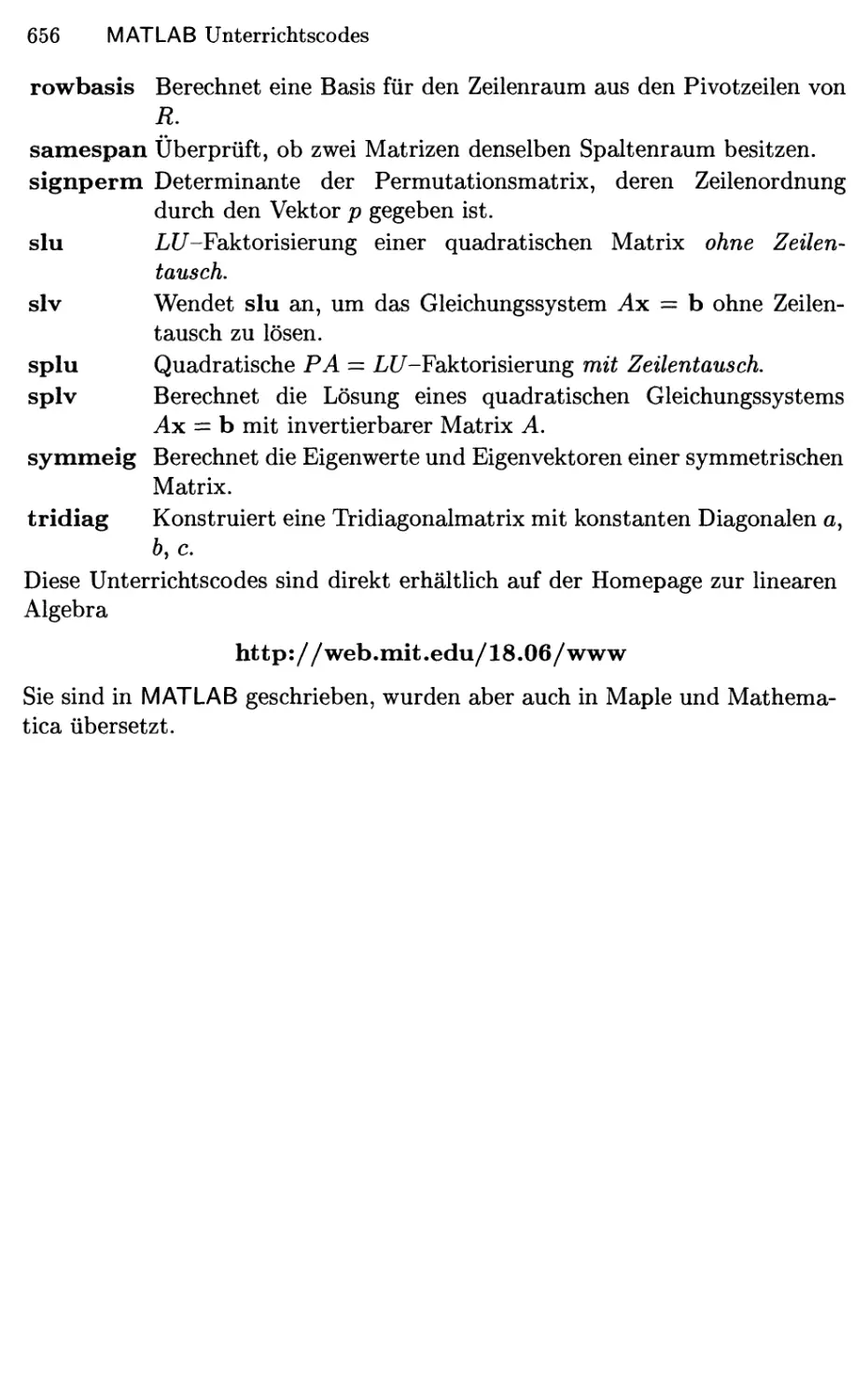

Berechnungen in der linearen Algebra

Der Text räumt dem wunderbaren Softwaresystem MATLAB den ersten Rang

ein, das speziell für die lineare Algebra entwickelt wurde. Es stellt die

Programmiersprache bereit, in der unsere Unterrichts codes von Cleve Moler für

die erste und von Steven Lee für diese [zweite amerikanische, Anm. d. Übers.]

Ausgabe geschrieben wurden. Die Unterrichtscodes befinden sich auf der

Webseite, zusammen mit den Hausaufgaben für MATLAB, Referenzmaterial

und einer kurzen Einführung. Die beste Art, hiermit zu beginnen, besteht

darin, Aufgaben zu lösen!

Wir bieten auch eine ähnliche Sammlung von Unterrichtscodes für Maple

und für Mathematica an. Am Ende des Buches befindet sich eine Liste dieser

Codes. Sie führen genau die Schritte aus, die wir im Text beschreiben. Der

Leser kann die Matrix-Theorie damit auf zwei Weisen kennenlernen — die

Algebra, und auch die Algorithmen. Sie fügen sich wunderbar zusammen.

Dieses Buch kann einem Kurs, der algorithmische Aspekte einschließt, ebenso

als Grundlage dienen wie einem Kurs, der dies nicht tut.

Es gibt so viel gute Mathematik zu lernen und zu betreiben.

Vorwort IX

Danksagungen

Ich habe viel Hilfe bei der Entstehung dieses Buches erfahren. Eine große

Anzahl von Lesern hat mir Vorschläge per E-Mail geschickt; ich danke Ihnen

dafür!

Steven Lee kam dreimal vom Oak Rigde National Laboratory an das

MIT zu Besuch, um den Kurs 18.06 Lineare Algebra nach diesem Buch zu

unterrichten. Er entwarf die Webseite http://web.init.edu/18.06/www,

und er fügte den MATLAB Unterrichtscodes, die von Cleve Moler für die erste

Ausgabe geschrieben worden waren, weitere hinzu. (Alle Unterrichtscodes

sind am Schluss des Buches aufgeführt.) Ich finde, diese kurzen Programme

illustrieren die wesentlichen Schritte der lineare Algebra auf eine sehr klare

Weise. Wenn Sie Hilfe irgendwelcher Art benötigen, schauen Sie bitte auf der

Webseite nach.

Ich möchte meinen tiefsten Dank für das Entstehen dieses Buches fünf

Freunden aussprechen. Die erste Ausgabe von 1993 wurde von Kai Borre und

Frank Jensen in Dänemark in das I^T^2e-Format gebracht. Es folgte die

hervorragende Arbeit von Sueli Rocha an der neuen Ausgabe. Zunächst am MIT,

und dann in Hong Kong, hat sie all die Aufregung, das Beinahe-Herzversagen

und schließlich das Triumphgefühl mitgemacht, die zur Veröffentlichung eines

Buches dazugehören. Vasily Strela war erfolgreich damit, die Abbildungen in

einen druckfertigen Zustand zu bringen (irgendwie, indem er die PostScript-

Dateien gelesen hat). Im entscheidenden letzten Schritt hat Amy Hendrickson

alles getan, was nötig war, um die Gestaltung zu vollenden. Sie ist ein

Profi ebenso sehr wie ein Freund. Ich hoffe, Sie werden die Wiederholung der

Wesentlichen Punkte am Ende eines jeden Abschnitts mögen, und die

deutlichen Kästchen in den Definitionen und Sätzen. Durch die Wiederholungen

und die Kästchen wird das Wichtigste herausgehoben, und meine Studenten

erinnerten sich gut daran.

Es gibt noch einen anderen besonderen Teil an diesem Buch: Den vorderen

Buchdeckel^. Vor etwa einem Monat erhielt ich eine seltsame Email von Ed

Curtis an der University of Washington. Er bestand darauf, dass ich das

Buch Great American Quilts: Book 5 kaufe, ohne zu sagen, warum. Es ist

vielleicht überflüssig zuzugeben, dass ich noch nicht besonders viele Quilts^

hergestellt habe. Auf Seite 131 dieses Buches fand ich einen erstaunlichen

Quilt, hergestellt von Chris Curtis. Sie hatte die erste Ausgabe dieses Buches

gesehen, auf dessen Einband geneigte Häuser zu sehen waren. Sie illustrieren,

was lineare Transformationen bewirken können, siehe Abschnitt 7.1. Chris

Anm. d. Übers.: Dies bezieht sich auf die zweite amerikanische Ausgabe. Der

Bucheinband ist im Internet abgebildet, zum Beispiel auf der Homepage des

Autors.

Anm. d. Übers.: Eine Art Flickendecke; bei der Verwendung des Wortes so wie

hier wird allerdings mehr Gewicht auf dessen künstlerische Gestaltung gelegt,

als man es mit dem deutschen Wort ausdrücken könnte.

X Vorwort

Curtis mochte diese Häuser, und sie machte sie schön. Möglicherweise sind

sie jetzt nichtlinear — aber das ist Kunst.

Ich bin dankbar dafür, dass Oxmoor House der Verwendung des Quilts auf

diesem Buch zugestimmt hat. Die Farbe wurde einhellig von zwei Personen

ausgewählt. Ich bin glücklich, Tracy Baldwin für die Gestaltung ihres dritten

Einbands für Wellesley-Cambridge Press danken zu können.

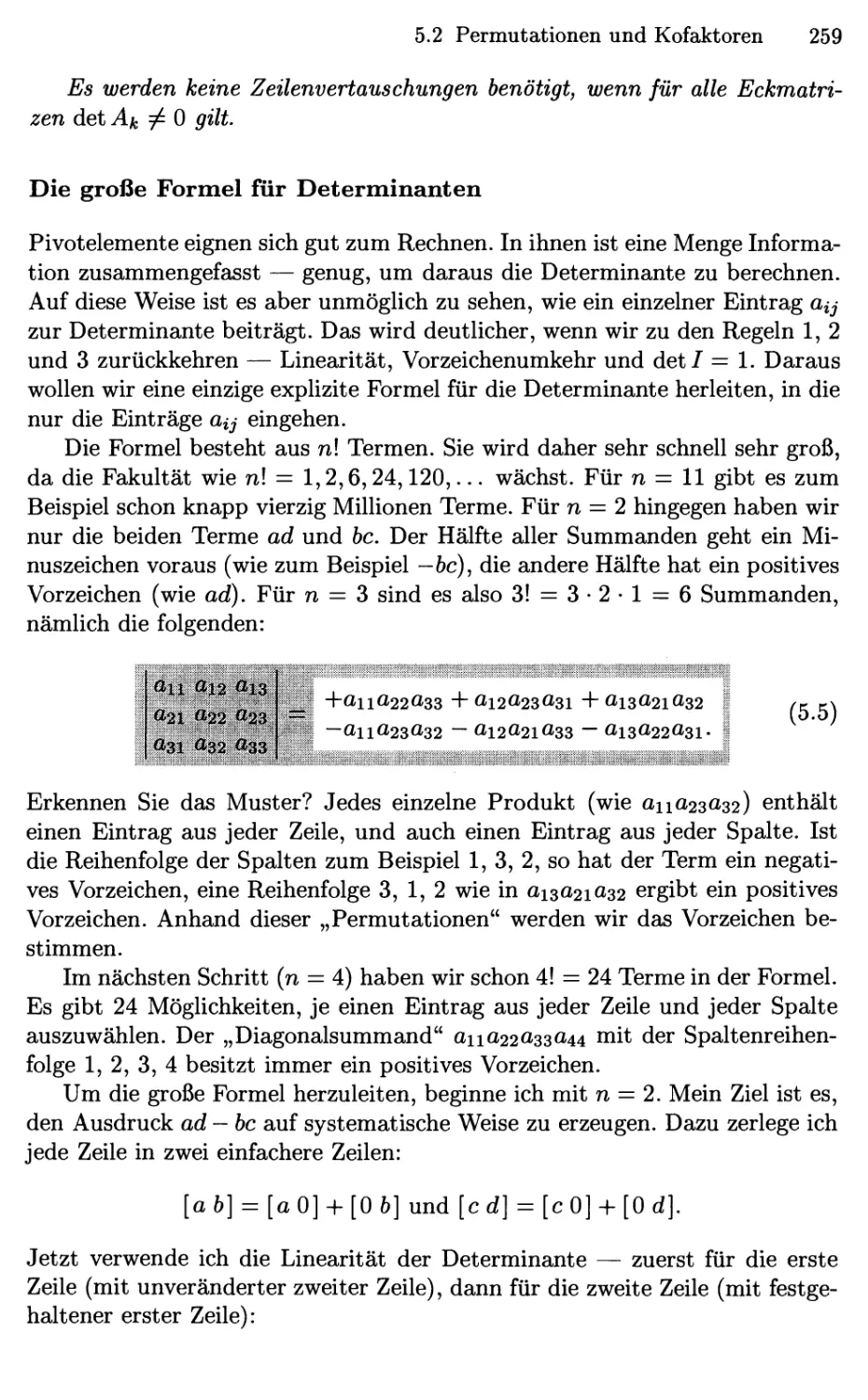

Ich möchte dieses Buch meinen Enkeln widmen. Es ist mir eine Freude,

die Namen derer zu nennen, die ich bislang kenne: Roger, Sophie, Kathryn,

Alexander, Scott, Jack, William und Caroline. Ich hoffe, dass Ihr alle eines

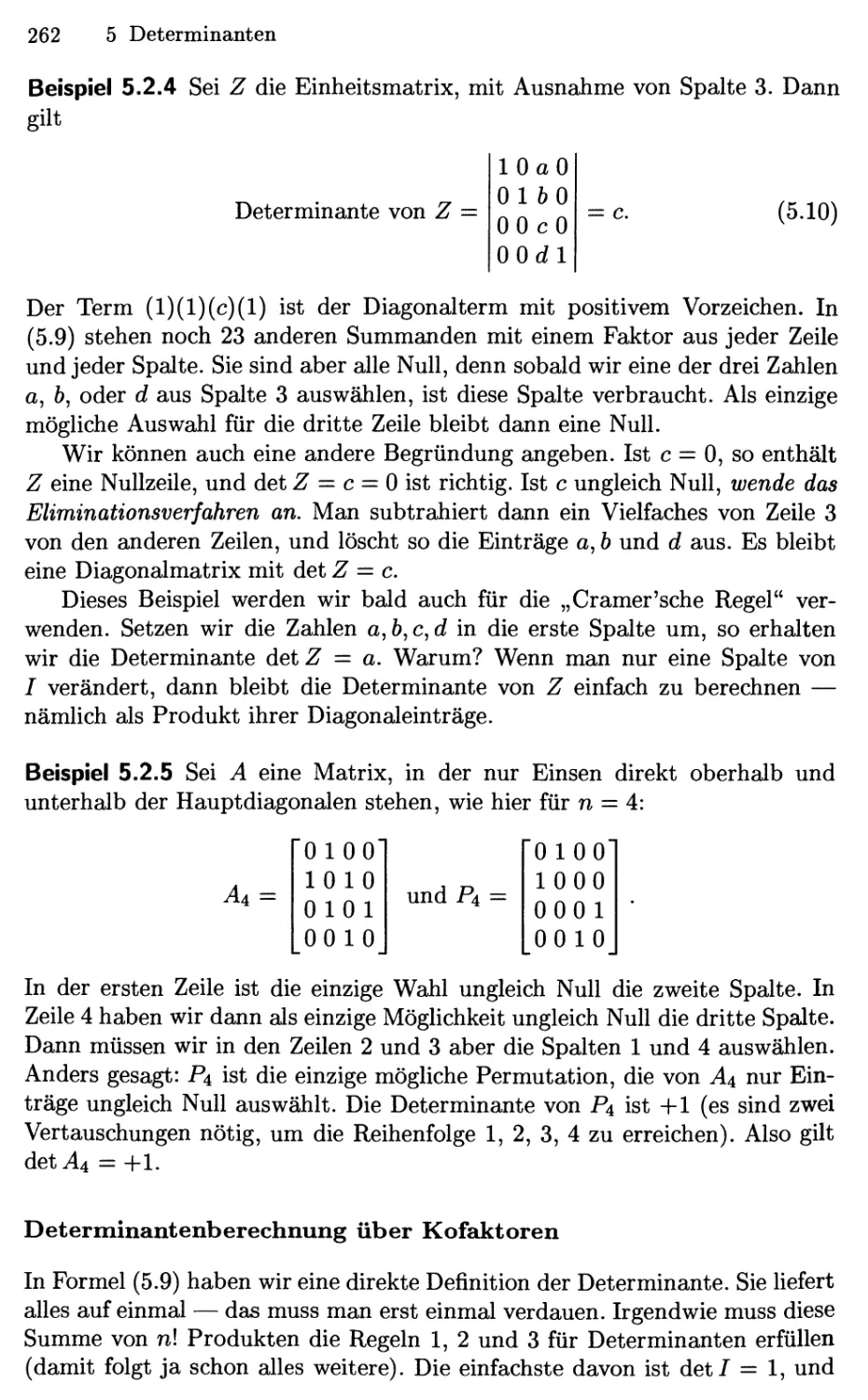

Tages diesen Kurs über lineare Algebra besuchen werdet. Bitte besteht ihn,

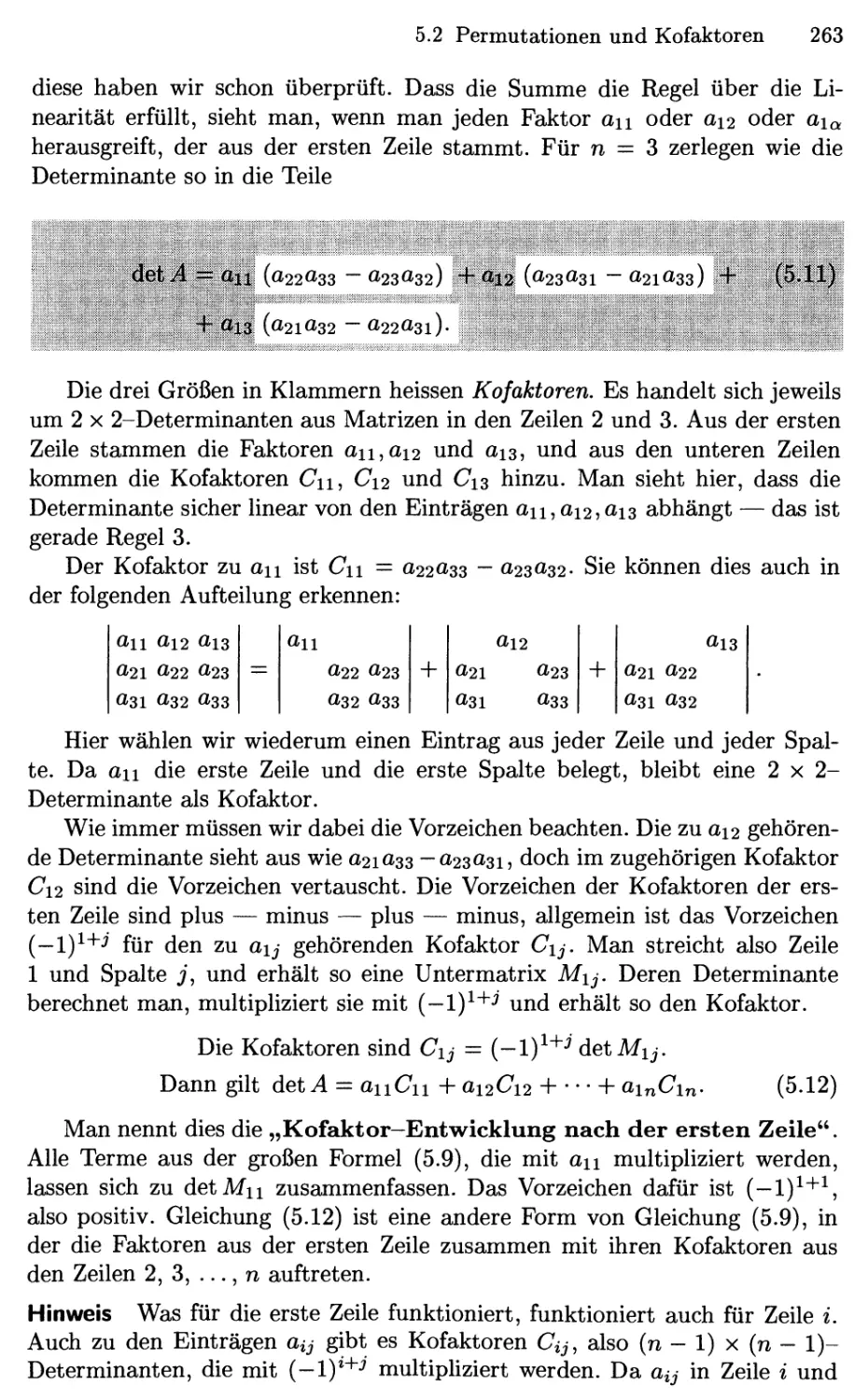

wie auch immer. Der Autor ist stolz auf Euch.

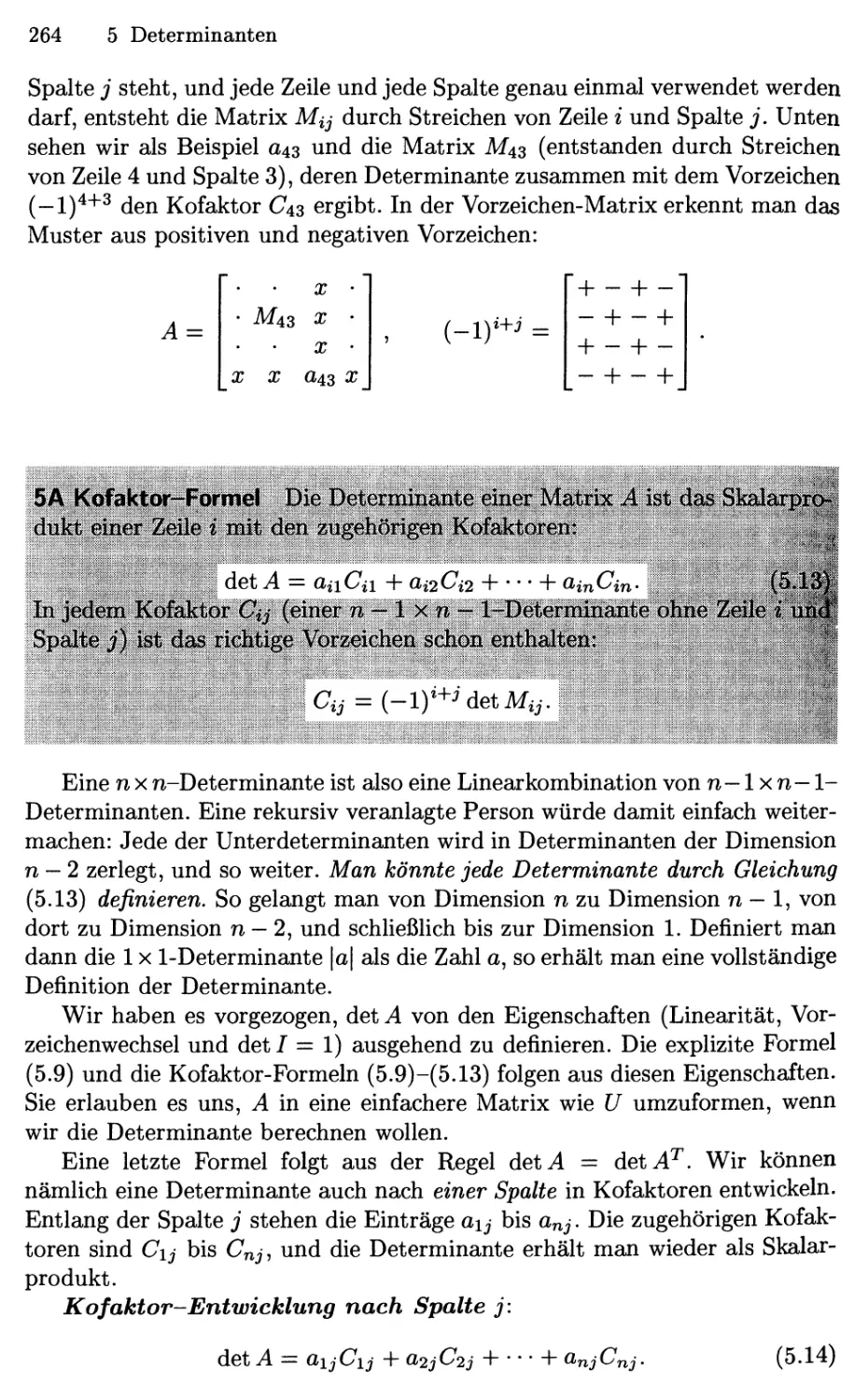

Februar 2003 Gilbert Strang

Inhaltsverzeichnis

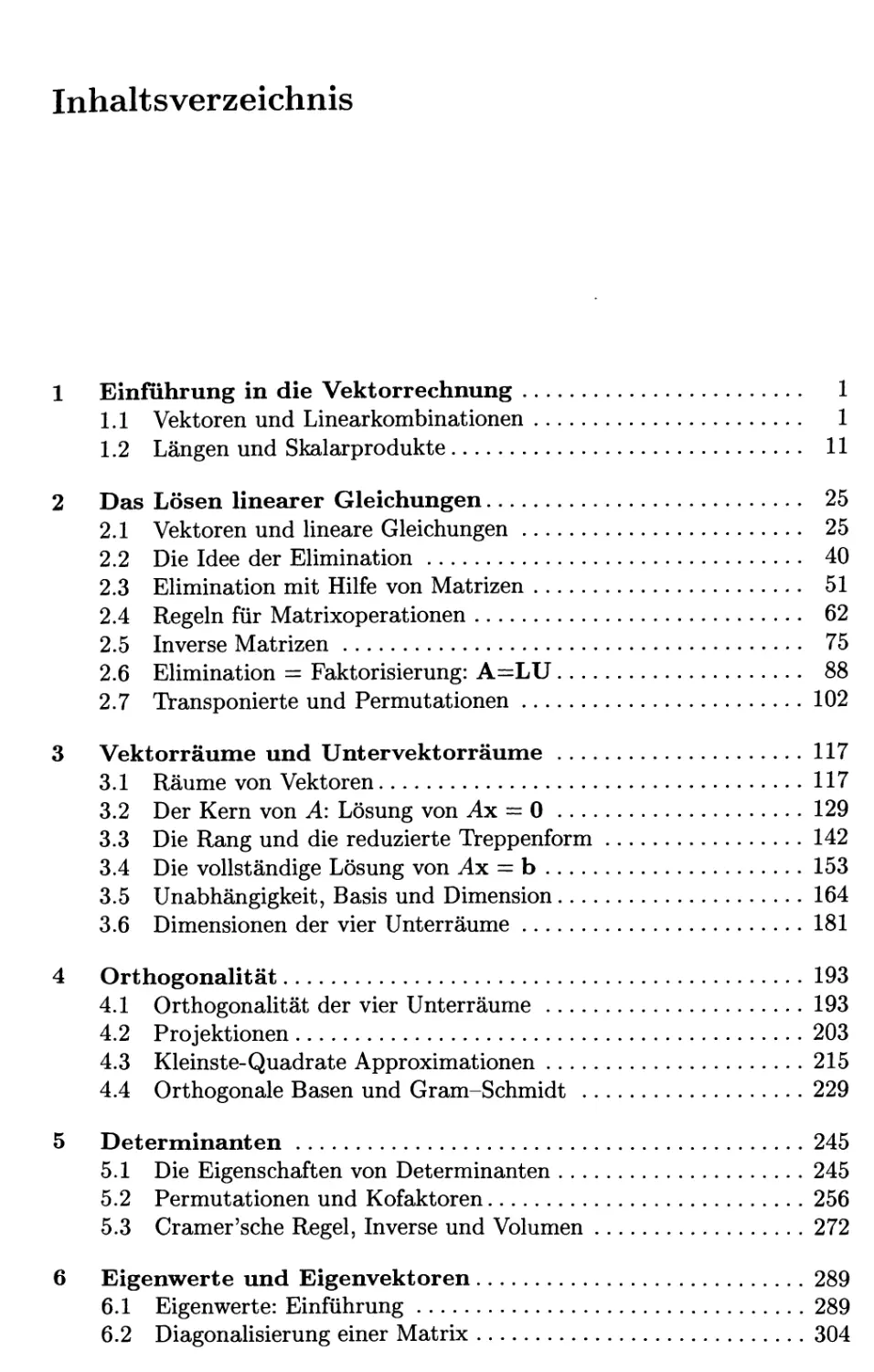

Einführung in die Vektorrechnung 1

1.1 Vektoren und Linearkombinationen 1

1.2 Längen und Skalarprodukte 11

Das Lösen linearer Gleichungen 25

2.1 Vektoren und lineare Gleichungen 25

2.2 Die Idee der Elimination 40

2.3 Elimination mit Hilfe von Matrizen 51

2.4 Regeln für Matrixoperationen 62

2.5 Inverse Matrizen 75

2.6 Elimination = Faktorisierung: A=:LU 88

2.7 Transponierte und Permutationen 102

Vektorräume und Untervektorräume 117

3.1 Räume von Vektoren 117

3.2 Der Kern von A: Lösung von Ax = 0 129

3.3 Die Rang und die reduzierte Treppenform 142

3.4 Die vollständige Lösung von ^x = b 153

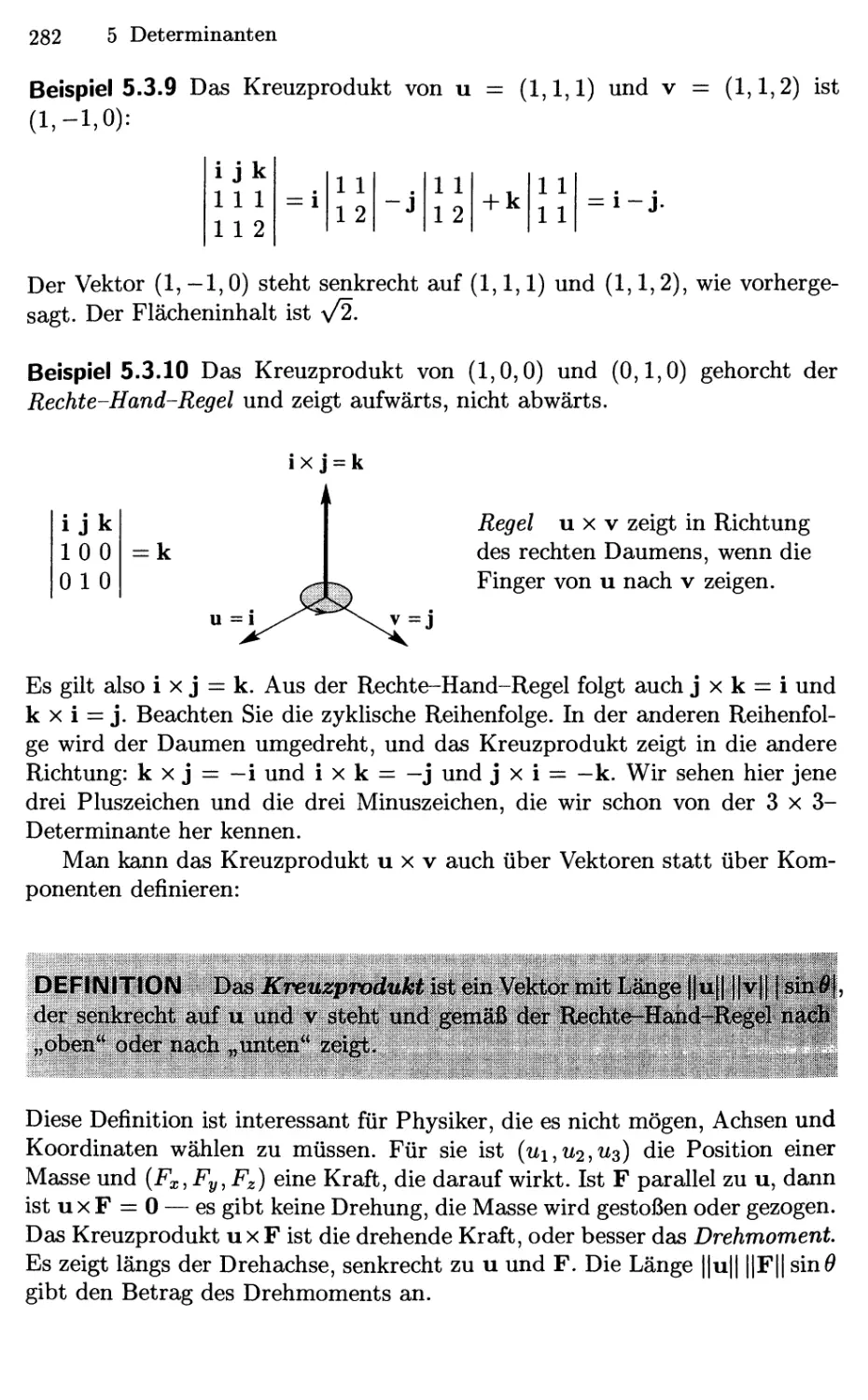

3.5 Unabhängigkeit, Basis und Dimension 164

3.6 Dimensionen der vier Unterräume 181

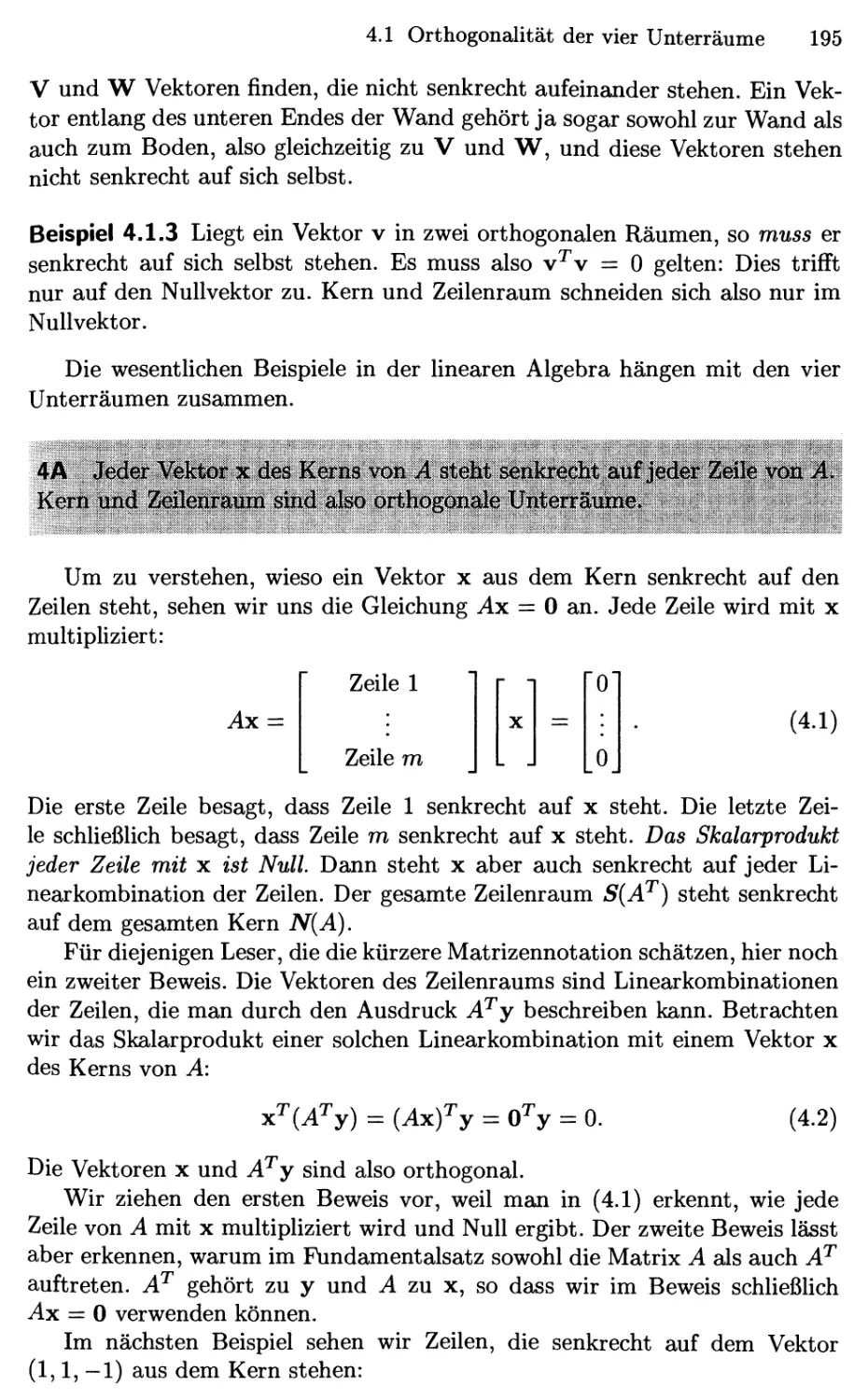

Orthogonalität 193

4.1 Orthogonalität der vier Unterräume 193

4.2 Projektionen 203

4.3 Kleinste-Quadrate Approximationen 215

4.4 Orthogonale Basen und Gram-Schmidt 229

Determinanten 245

5.1 Die Eigenschaften von Determinanten 245

5.2 Permutationen und Kofaktoren 256

5.3 Cramer'sehe Regel, Inverse und Volumen 272

Eigenwerte und Eigenvektoren 289

6.1 Eigenwerte: Einführung 289

6.2 Diagonalisierung einer Matrix 304

XII Inhaltsverzeichnis

6.3 Anwendungen bei Differentialgleichungen 319

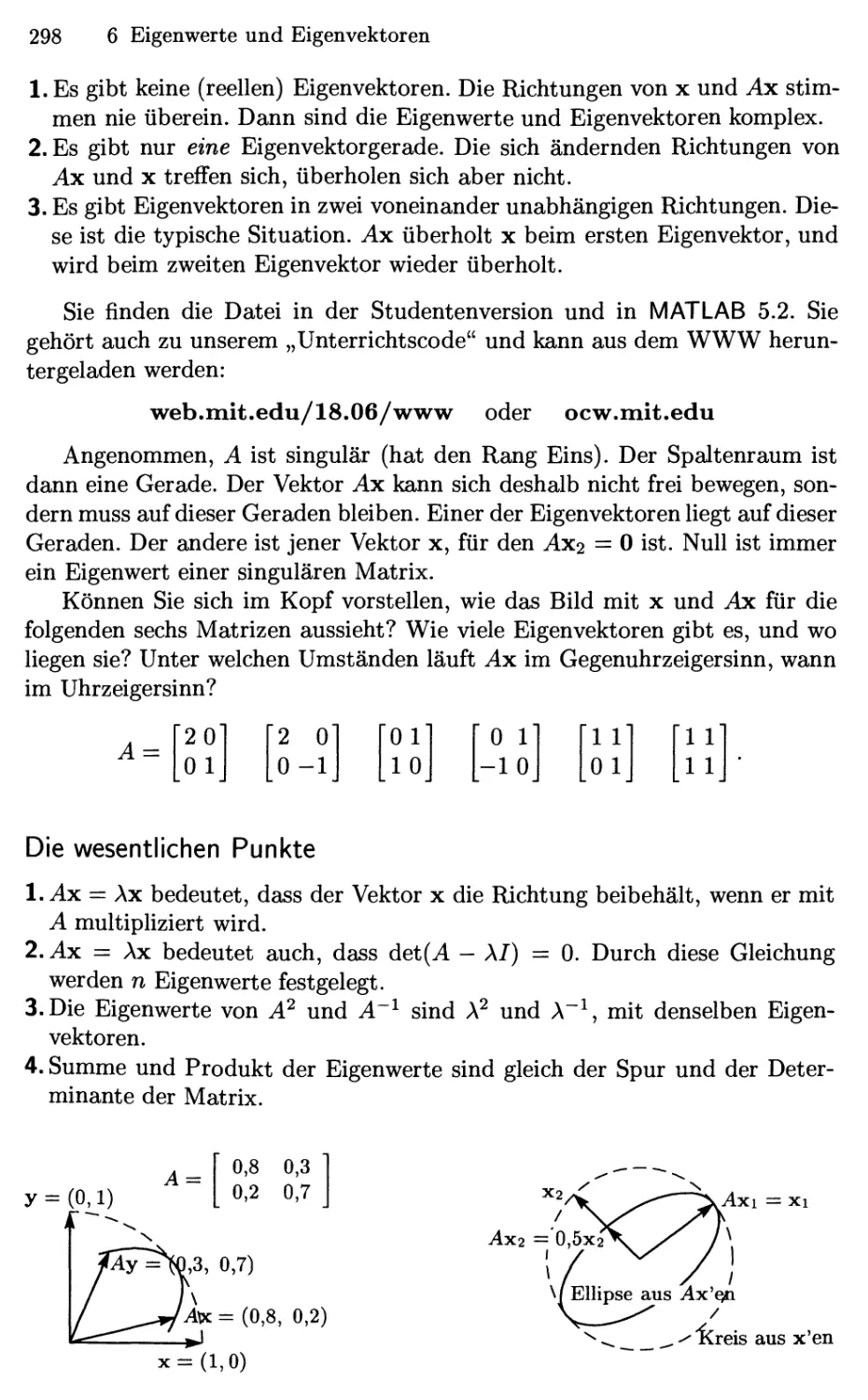

6.4 Symmetrische Matrizen 333

6.5 Positiv definite Matrizen 346

6.6 ÄhnUche Matrizen 360

6.7 Singulärwertzerlegung 368

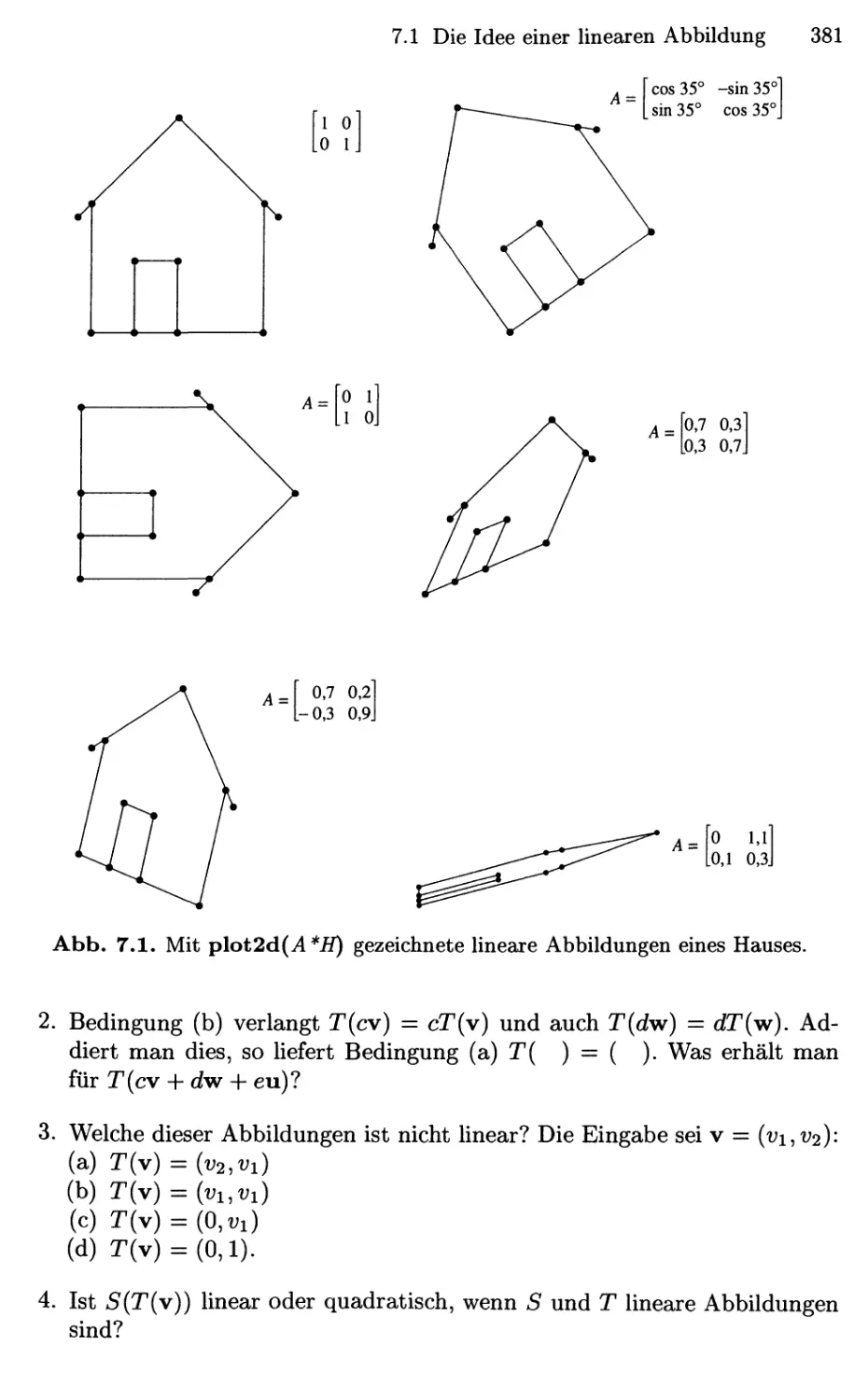

7 Lineare Abbildungen 377

7.1 Die Idee einer linearen Abbildung 377

7.2 Die Matrix einer linearen Abbildung 385

7.3 Basiswechsel 399

7.4 Diagonalisierung und Pseudoinverse 406

8 Anwendungen 419

8.1 Graphen und Netzwerke 419

8.2 Markov-Matrizen und Wirtschaftsmodelle 432

8.3 Lineare Programmierung 441

8.4 Fourier reihen: Lineare Algebra für Funktionen 449

8.5 Computergrafik 457

9 Numerische lineare Algebra 465

9.1 Gauß'sche Elimination in der Praxis 465

9.2 Normen und Konditionszahlen 476

9.3 Iterative Methoden für lineare Algebra 484

10 Komplexe Vektoren und Matrizen 497

10.1 Komplexe Zahlen 497

10.2 Hermitesche und unitäre Matrizen 507

10.3 Die schnelle Fouriertransformation 517

Lösungen zu ausgewählten Aufgaben 527

Eine Abschlussklausur 587

Matrix-Faktorisierungen 591

Durchgerechnete Aufgaben 595

Index 649

Unterrichtscodes 655

1 Einführung in die Vektorrechnung

Im Zentrum der linearen Algebra stehen zwei Operationen — beide werden

mit Vektoren ausgeführt. Wir addieren Vektoren v, w, um v + w zu erhalten.

Wir multiplizieren sie mit Zahlen c und d, um cv und dw zu erhalten. Die

Kombination dieser Operationen ergibt die Linearkombination cv + dw.

Im ersten Kapitel werden diese beiden zentralen Ideen erläutert, auf

denen anschließend alles weitere aufbaut. Wir beginnen zunächst mit zwei- und

dreidimensionalen Vektoren, denn diese sind auch zeichnerisch gut

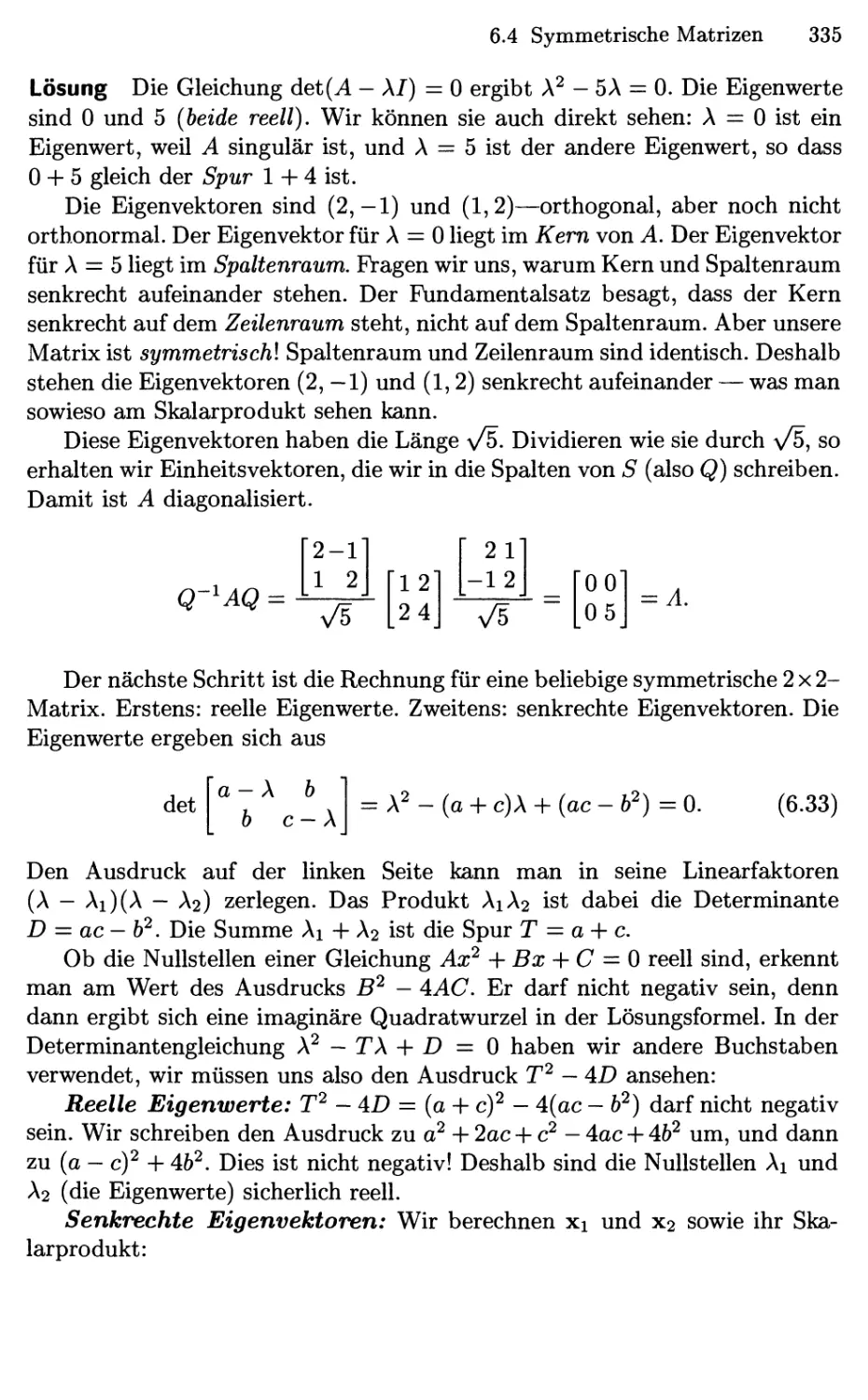

darstellbar. Danach gehen wir zu höheren Dimensionen über. Das wirklich

Beeindruckende an der Linearen Algebra besteht darin, dass dieser Schritt in den

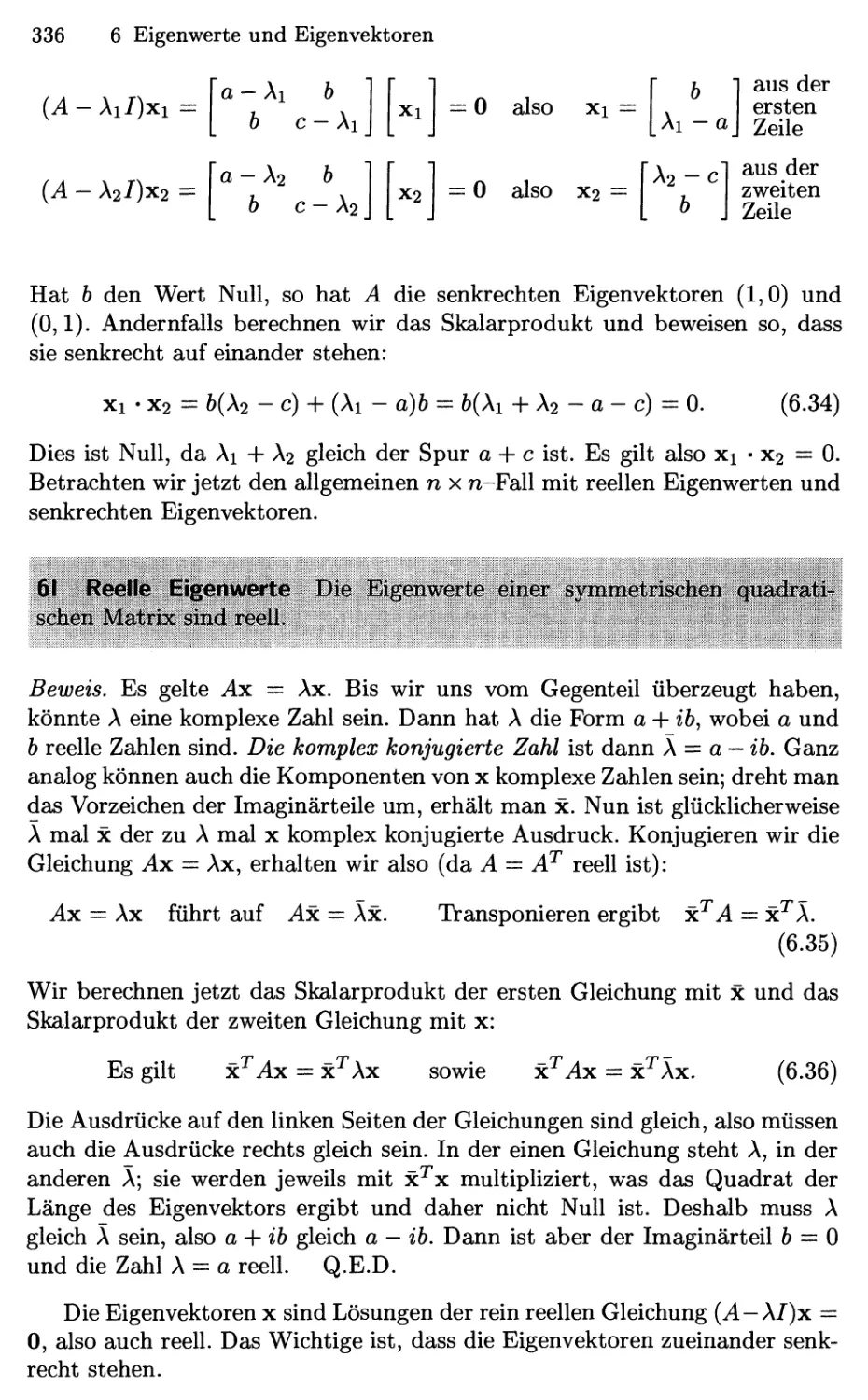

n-dimensionalen Raum problemlos durchführbar ist. Die geometrische

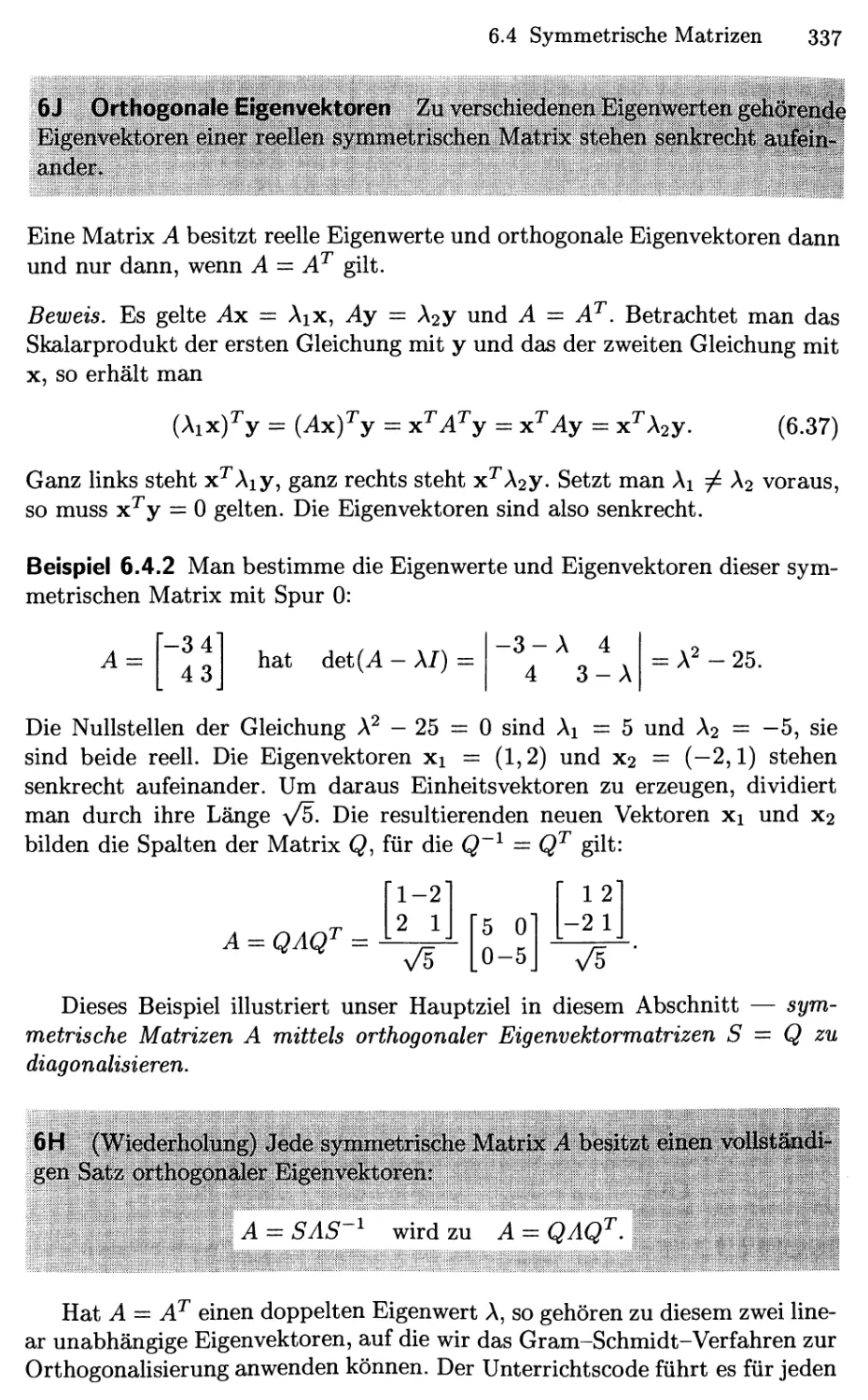

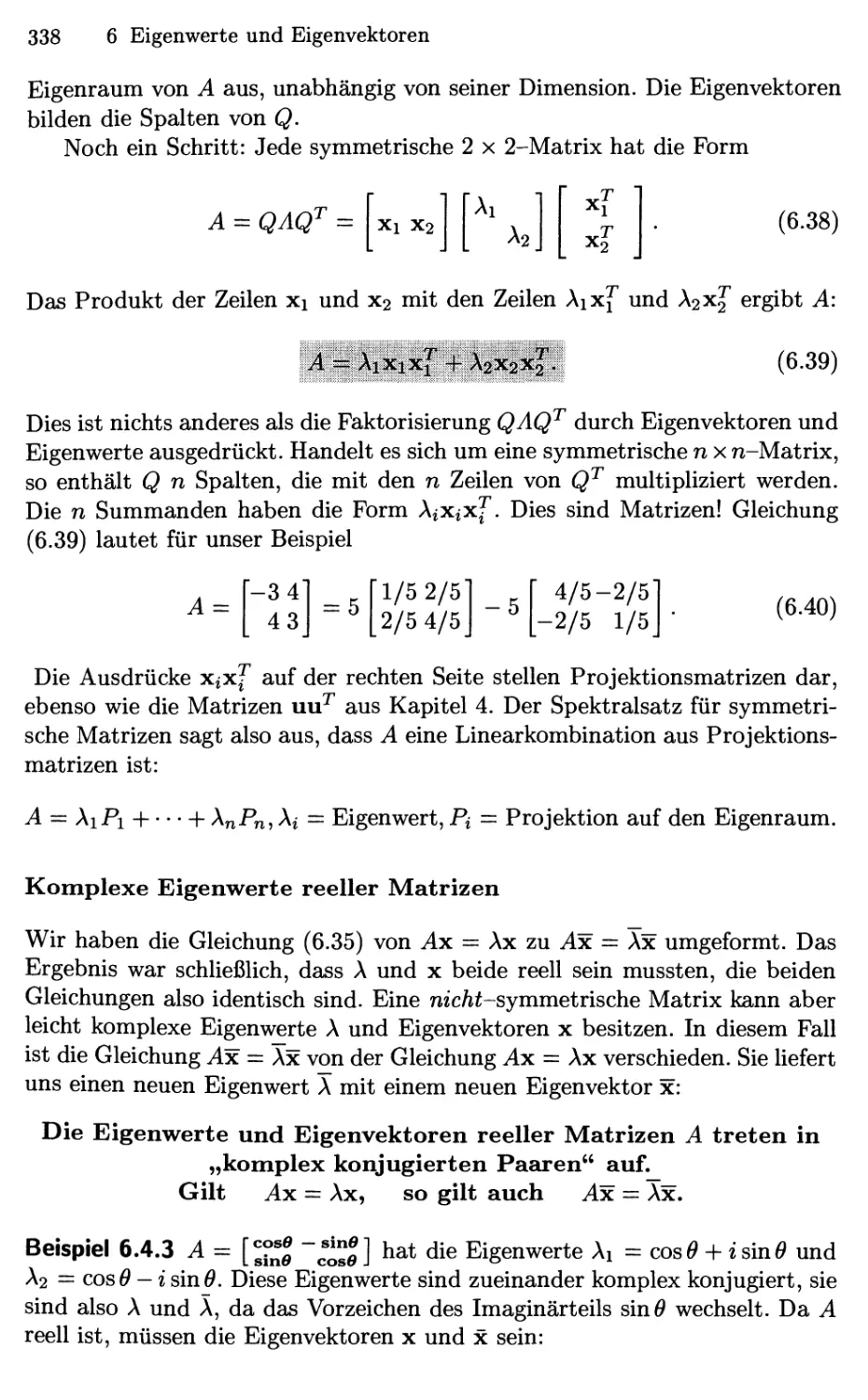

Vorstellung aus zwei und drei Dimensionen bleibt hierbei völlig korrekt, auch

wenn man einen zehndimensionalen Vektor nicht mehr zeichnen kann.

Dorthin wird das Buch uns führen (in den n-dimensionalen Raum), und

als erste Schritte betrachten wir die beiden Operationen, die in den

Abschnitten 1.1 und 1.2 eingeführt werden:

1.1 Vektoraddition v + w und Linearkombinationen cv + dw.

1.2 Das Skalarprodukt vw und die Länge ||v|| — y^v • v.

1.1 Vektoren und Linearkombinationen

„Man kann Äpfel nicht mit Birnen vergleichen." Das mag nichts Neues sein,

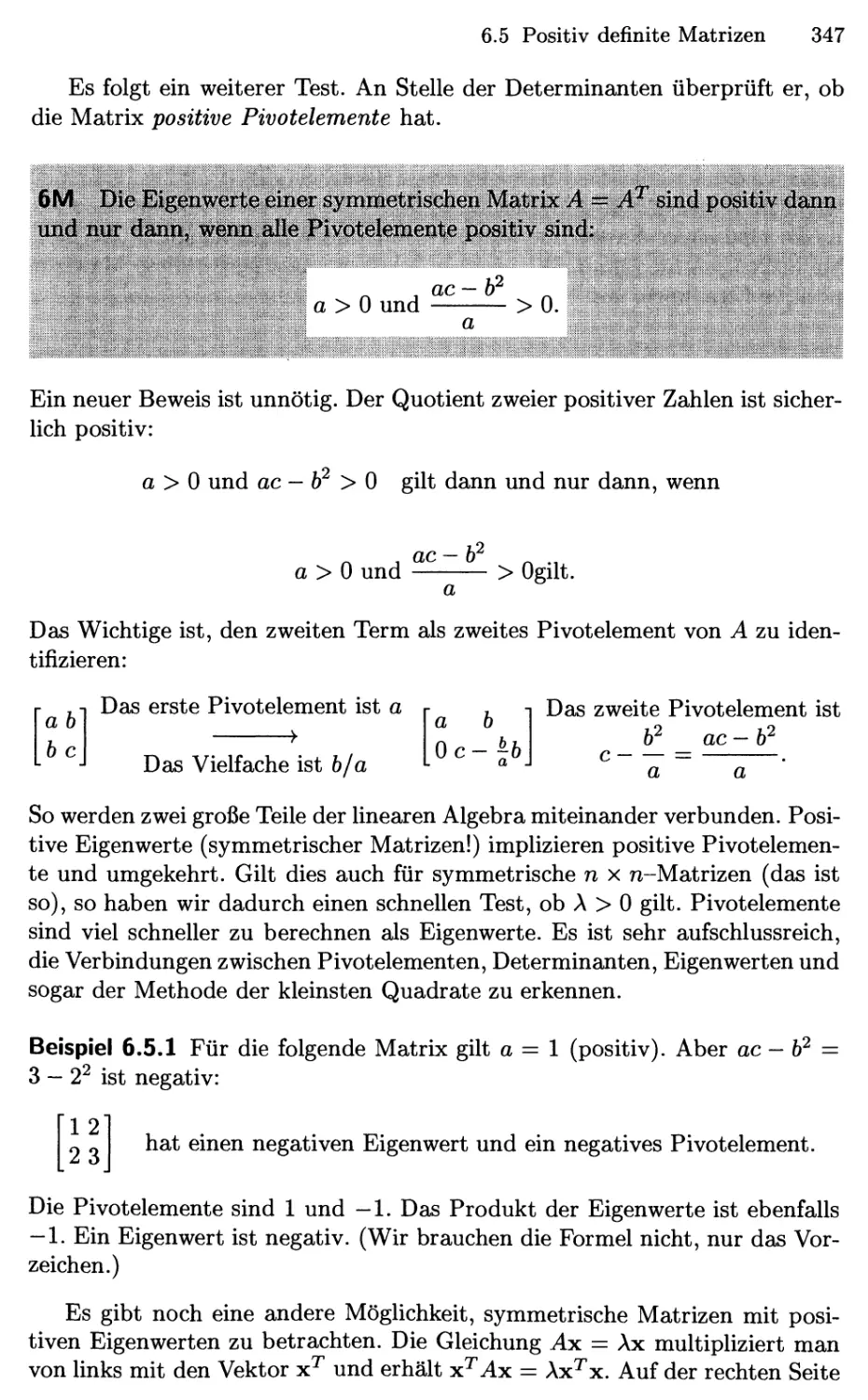

doch der Satz enthält für uns einen wesentlichen Inhalt. Seltsamerweise

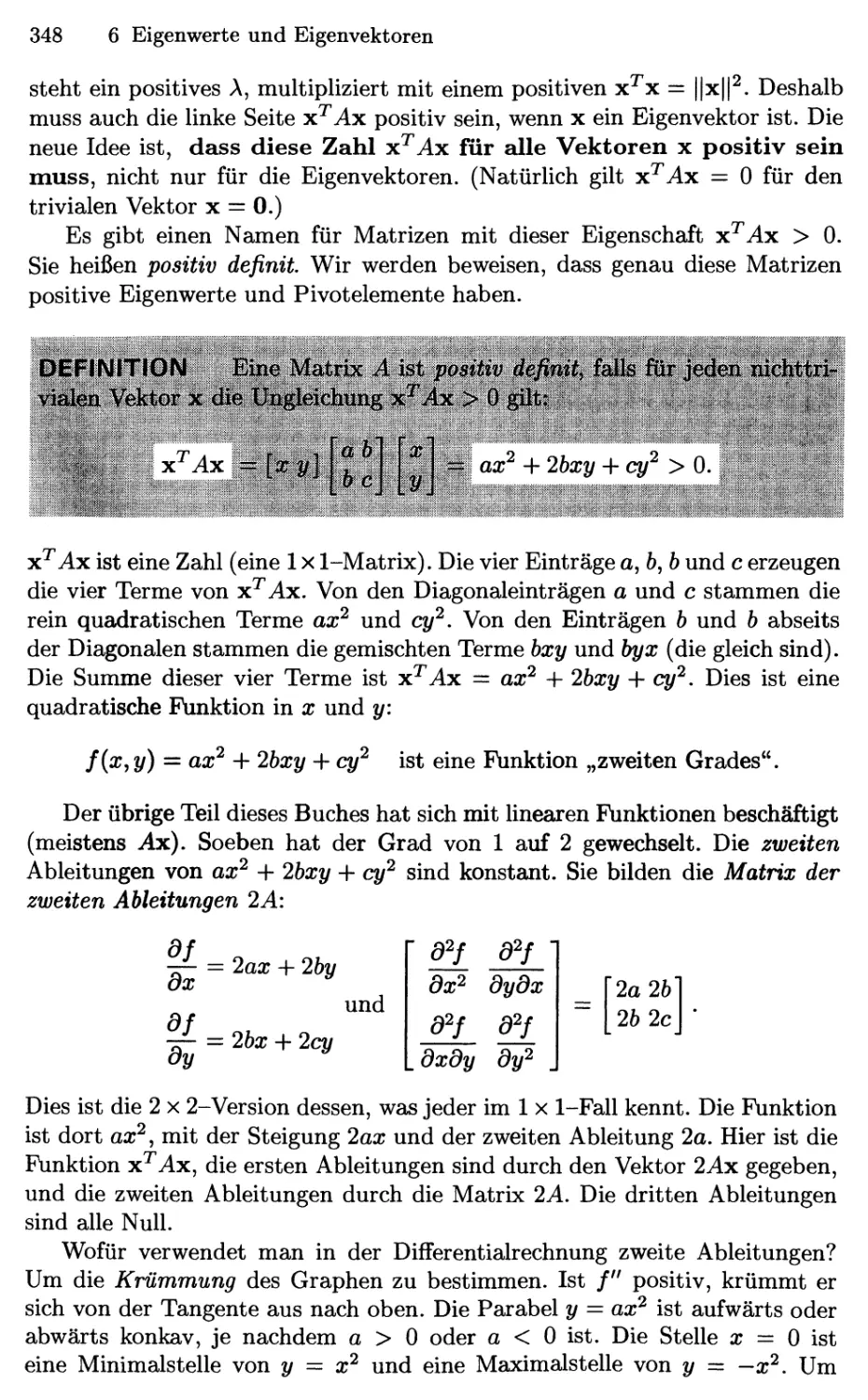

besteht hierin der Grund dafür, dass es Vektoren gibt! Wenn man nämHch die

Anzahl der Äpfel getrennt von der Anzahl der Birnen betrachtet, so erhält

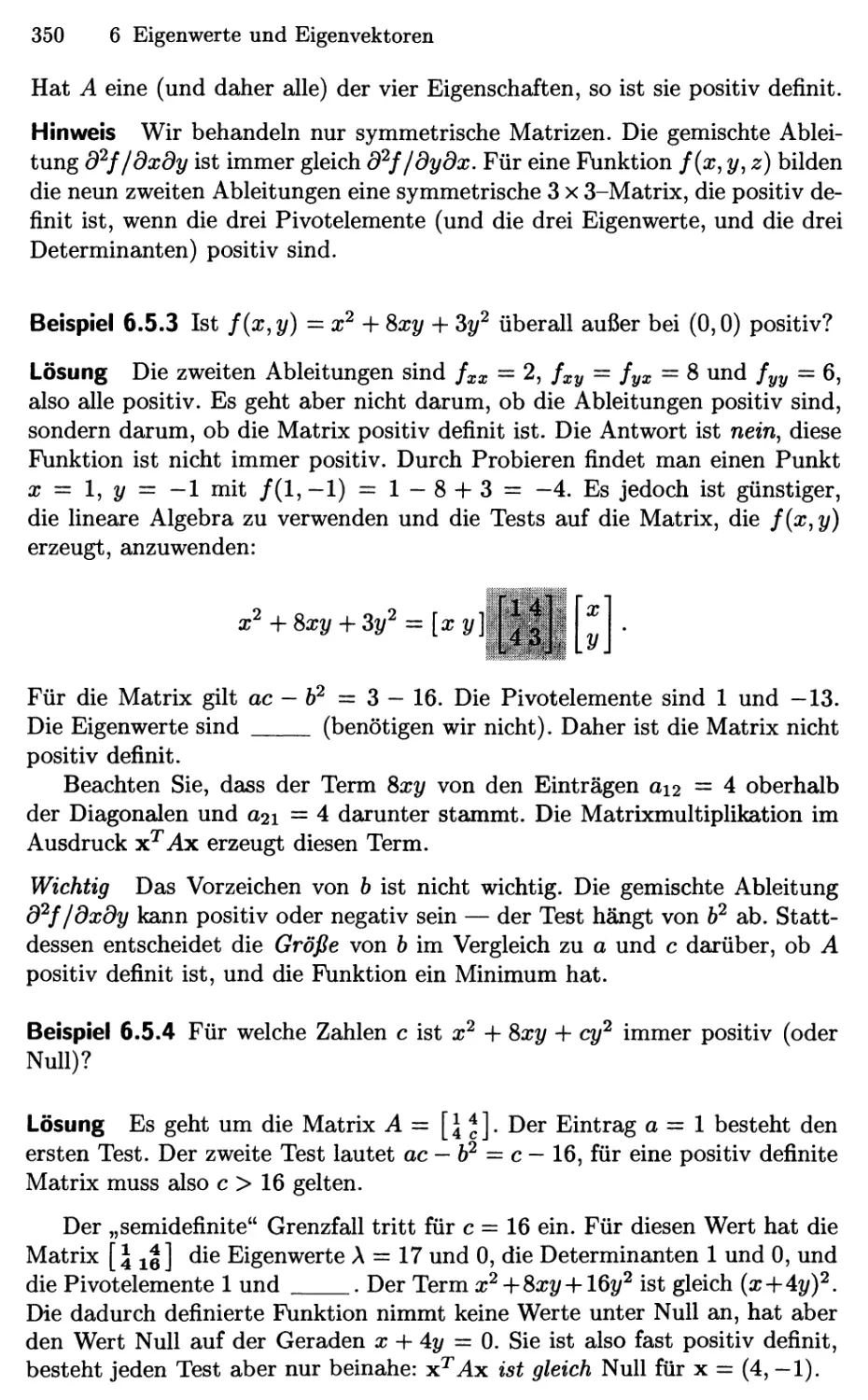

man ein Paar von Zahlen. Dieses Paar ist ein zweidimensionaler Vektor v:

Vi = Anzahl der Äpfel

V2 = Anzahl der Birnen.

Hierbei haben wir v als einen Spaltenvektor geschrieben. Die Zahlen vi

und V2 sind seine „Komponenten." Ein wesentlicher Aspekt liegt darin, dass

wir einen einzigen Buchstaben v (fett gedruckt) für das Zahlenpaar vi und V2

(kursiv gedruckt) schreiben. Selbst wenn wir vi nicht zu V2 addieren können,

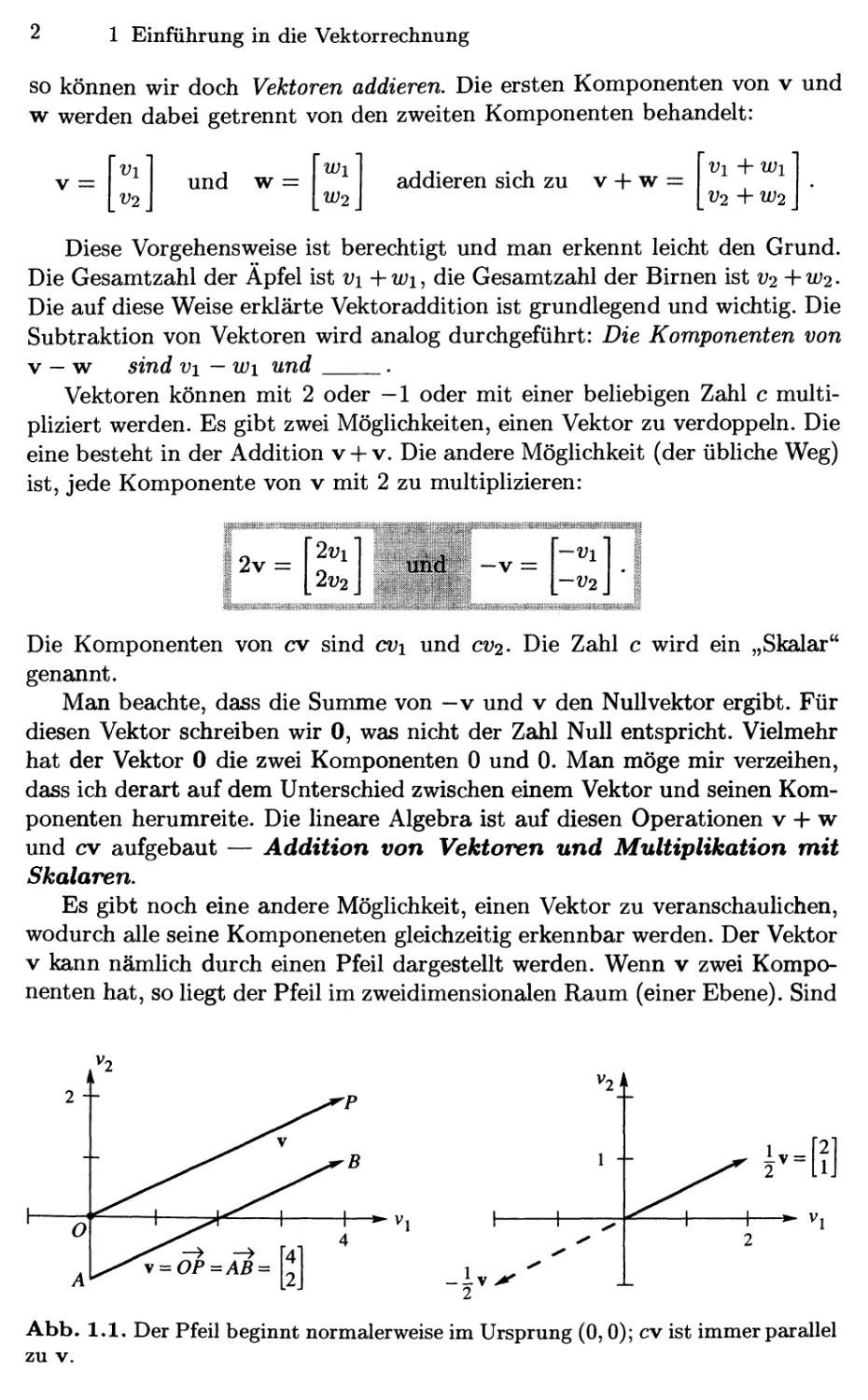

2 1 Einführung in die Vektorrechnung

so können wir doch Vektoren addieren. Die ersten Komponenten von v und

w werden dabei getrennt von den zweiten Komponenten behandelt:

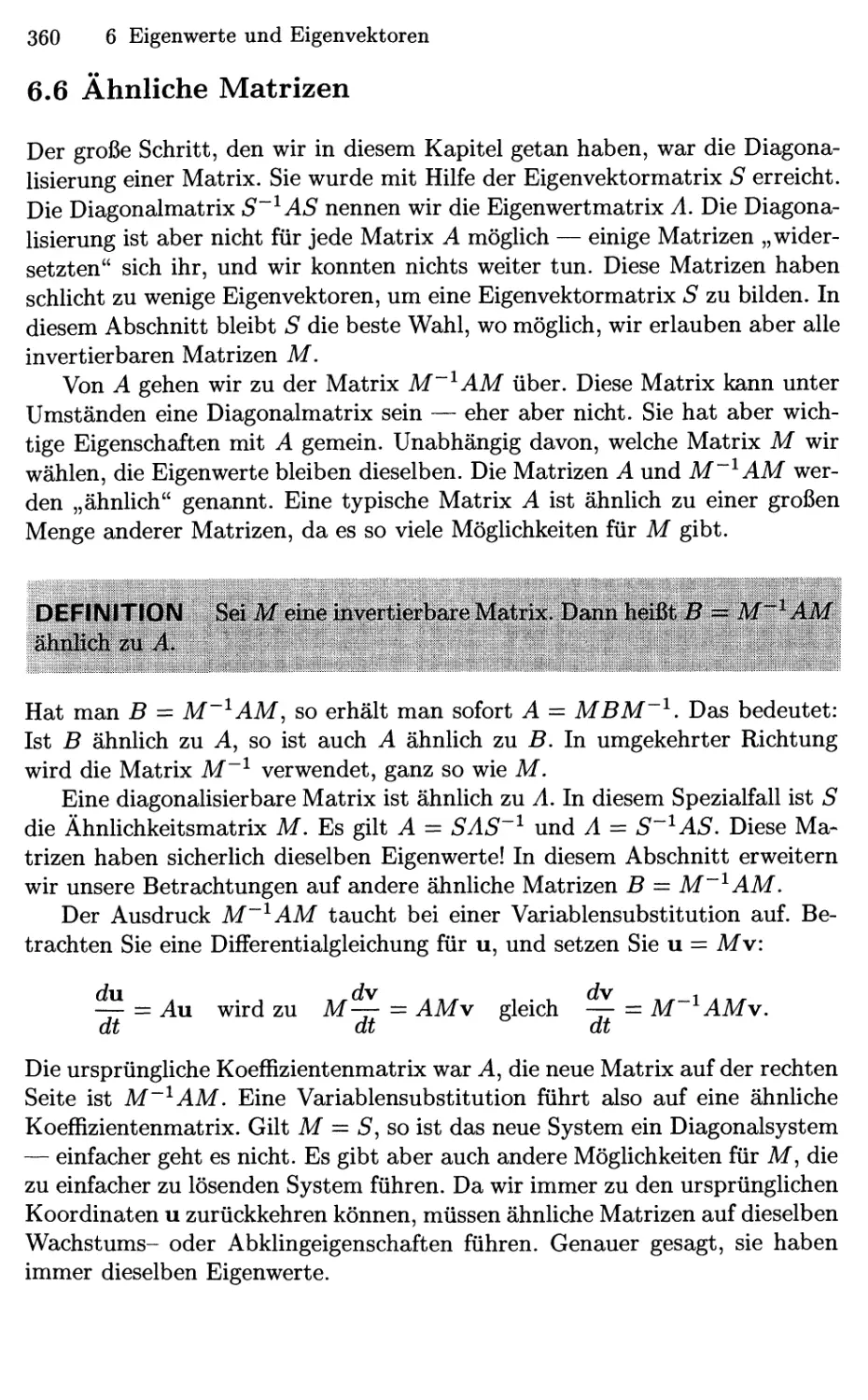

V =

und w

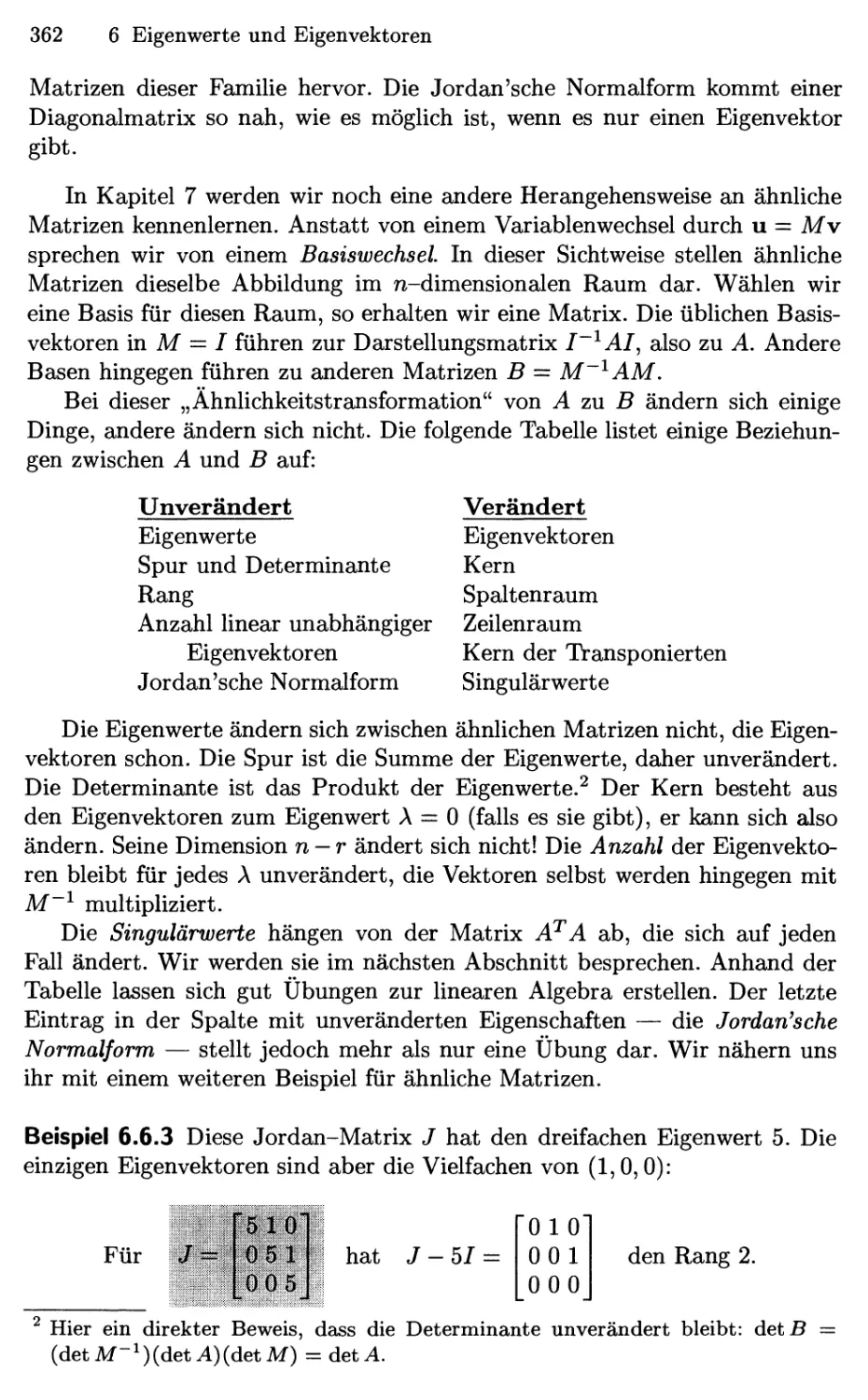

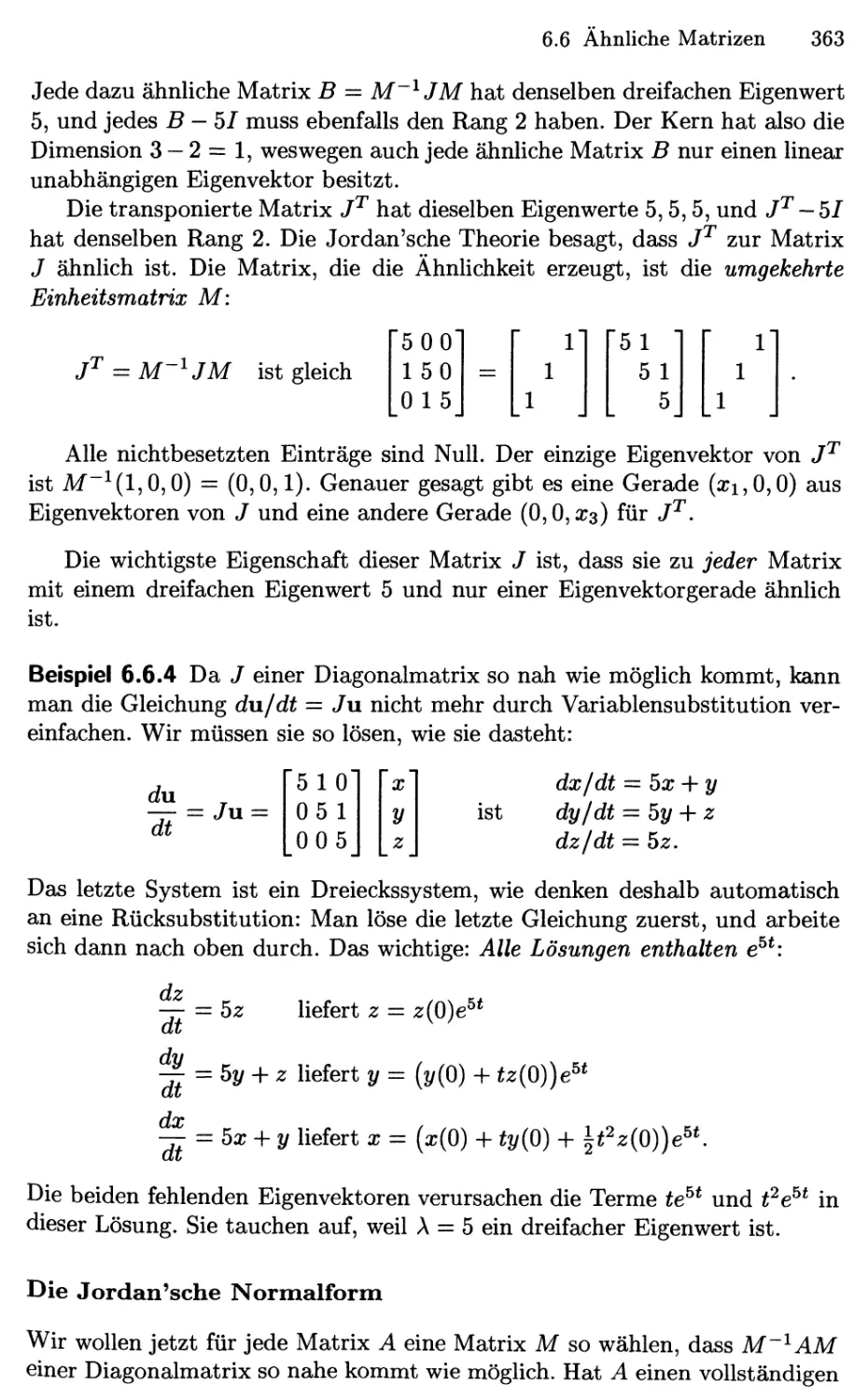

Wi

W2

addieren sich zu v -f w =

Vi -\-Wi

V2 -\-W2

Diese Vorgehens weise ist berechtigt und man erkennt leicht den Grund.

Die Gesamtzahl der Äpfel ist Vi-\-wi, die Gesamtzahl der Birnen ist V2+W2.

Die auf diese Weise erklärte Vektoraddition ist grundlegend und wichtig. Die

Subtraktion von Vektoren wird analog durchgeführt: Die Komponenten von

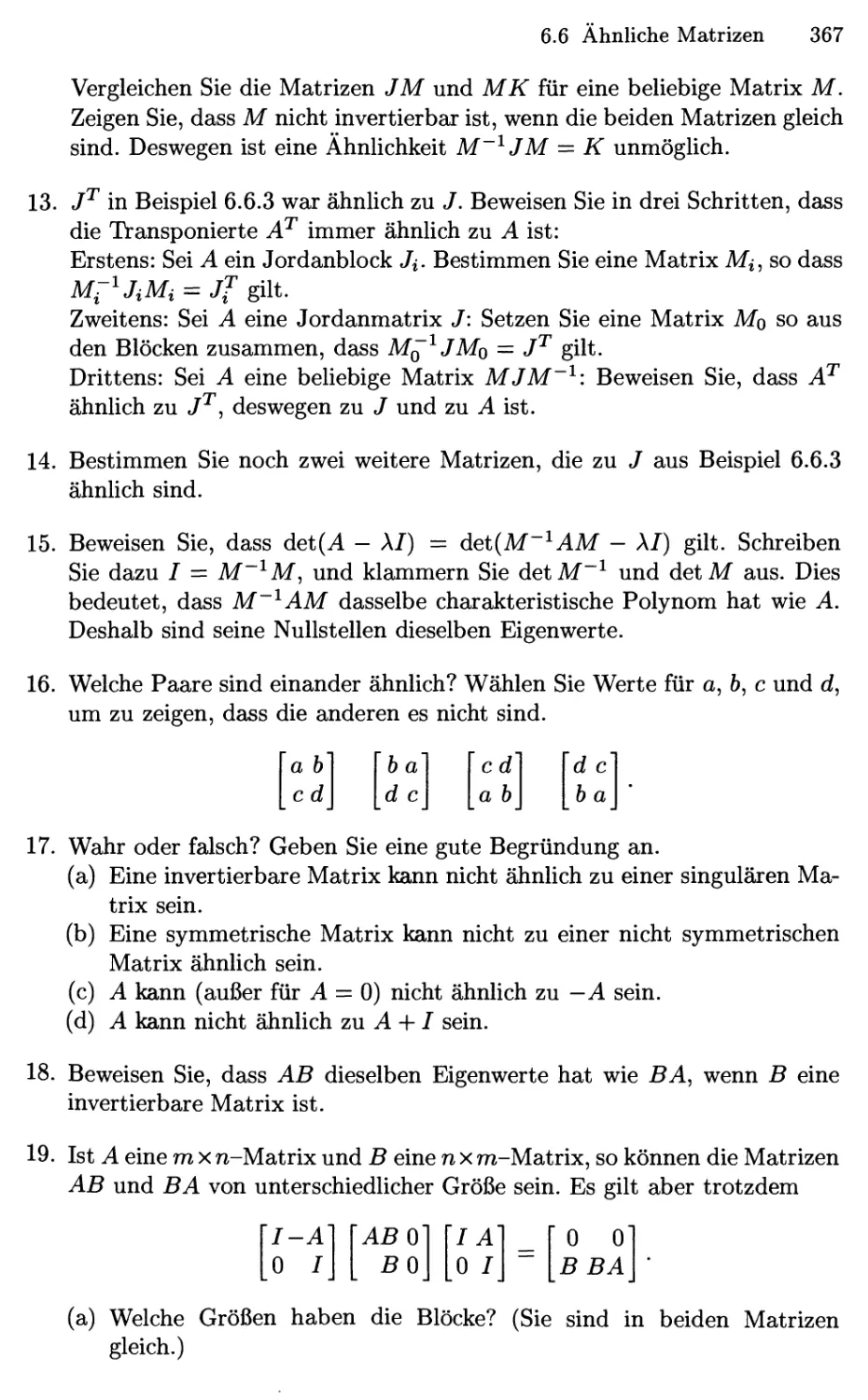

V — w sind Vi — wi und .

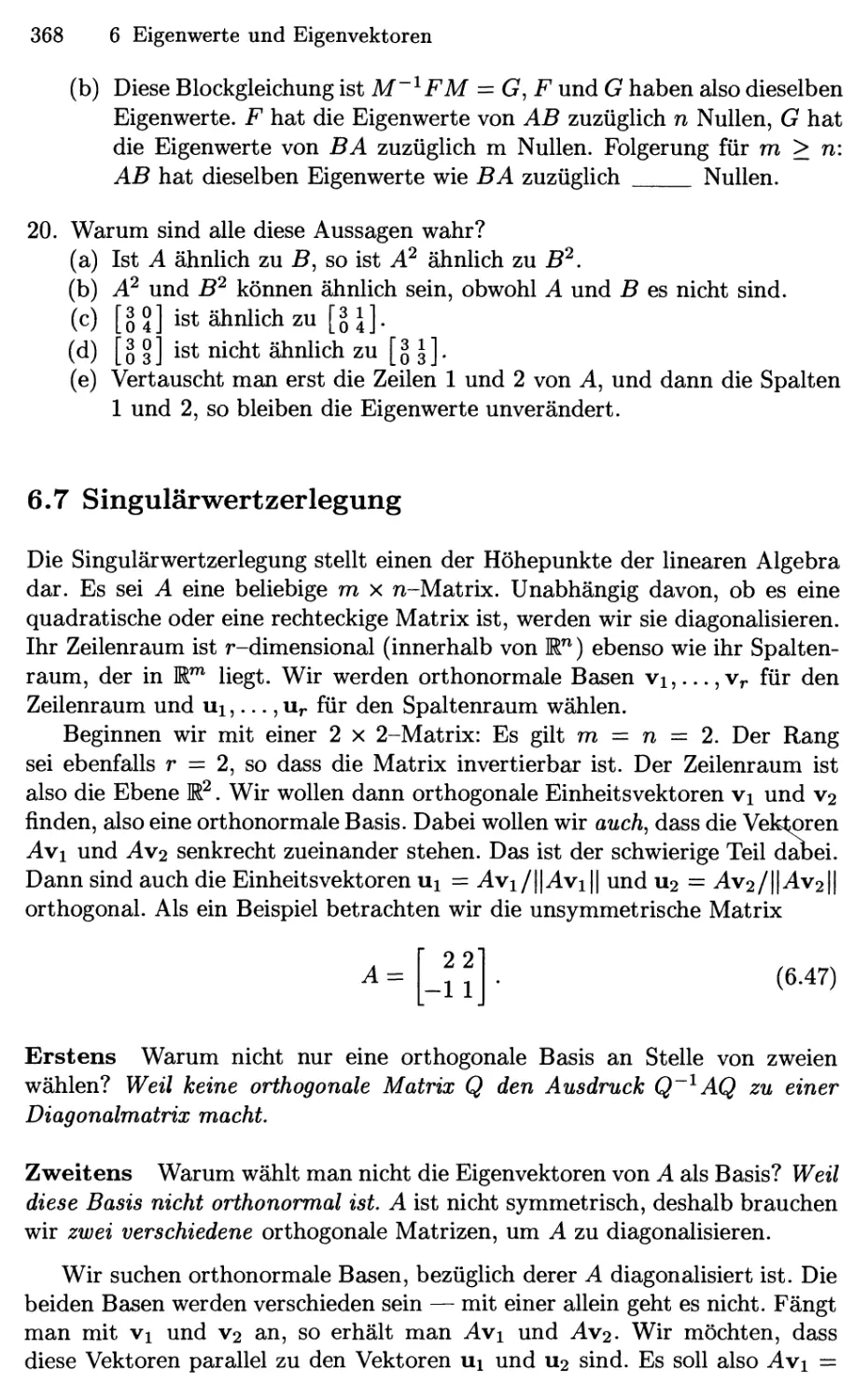

Vektoren können mit 2 oder -1 oder mit einer beliebigen Zahl c

multipliziert werden. Es gibt zwei Möglichkeiten, einen Vektor zu verdoppeln. Die

eine besteht in der Addition v + v. Die andere Möglichkeit (der übUche Weg)

ist, jede Komponente von v mit 2 zu multiplizieren:

2v

2i;i

2i;2

-V =

-Vi

-V2

Die Komponenten von cv sind cvi und cv2' Die Zahl c wird ein „Skalar"

genannt.

Man beachte, dass die Summe von -v und v den Nullvektor ergibt. Für

diesen Vektor schreiben wir 0, was nicht der Zahl Null entspricht. Vielmehr

hat der Vektor 0 die zwei Komponenten 0 und 0. Man möge mir verzeihen,

dass ich derart auf dem Unterschied zwischen einem Vektor und seinen

Komponenten herumreite. Die lineare Algebra ist auf diesen Operationen v -+- w

und cv aufgebaut — Addition von Vektoren und Multiplikation mit

Skalaren.

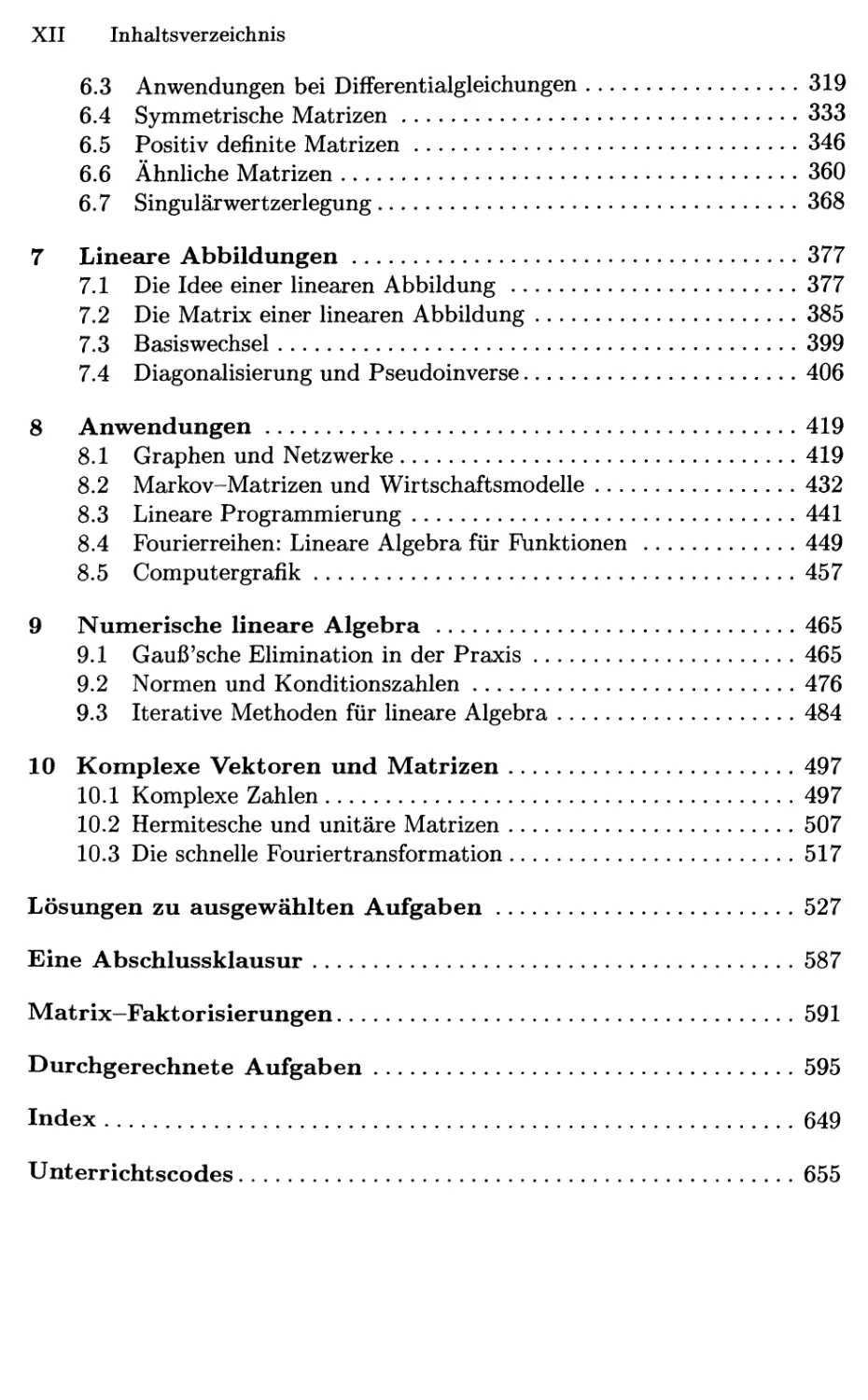

Es gibt noch eine andere Möglichkeit, einen Vektor zu veranschaulichen,

wodurch alle seine Komponeneten gleichzeitig erkennbar werden. Der Vektor

V kann nämlich durch einen Pfeil dargestellt werden. Wenn v zwei

Komponenten hat, so liegt der Pfeil im zweidimensionalen Raum (einer Ebene). Sind

^—► V,

ly^

Abb. 1.1. Der Pfeil beginnt normalerweise im Ursprung @,0); cv ist immer parallel

zu v.

1.1 Vektoren und Linearkombinationen

v =

2

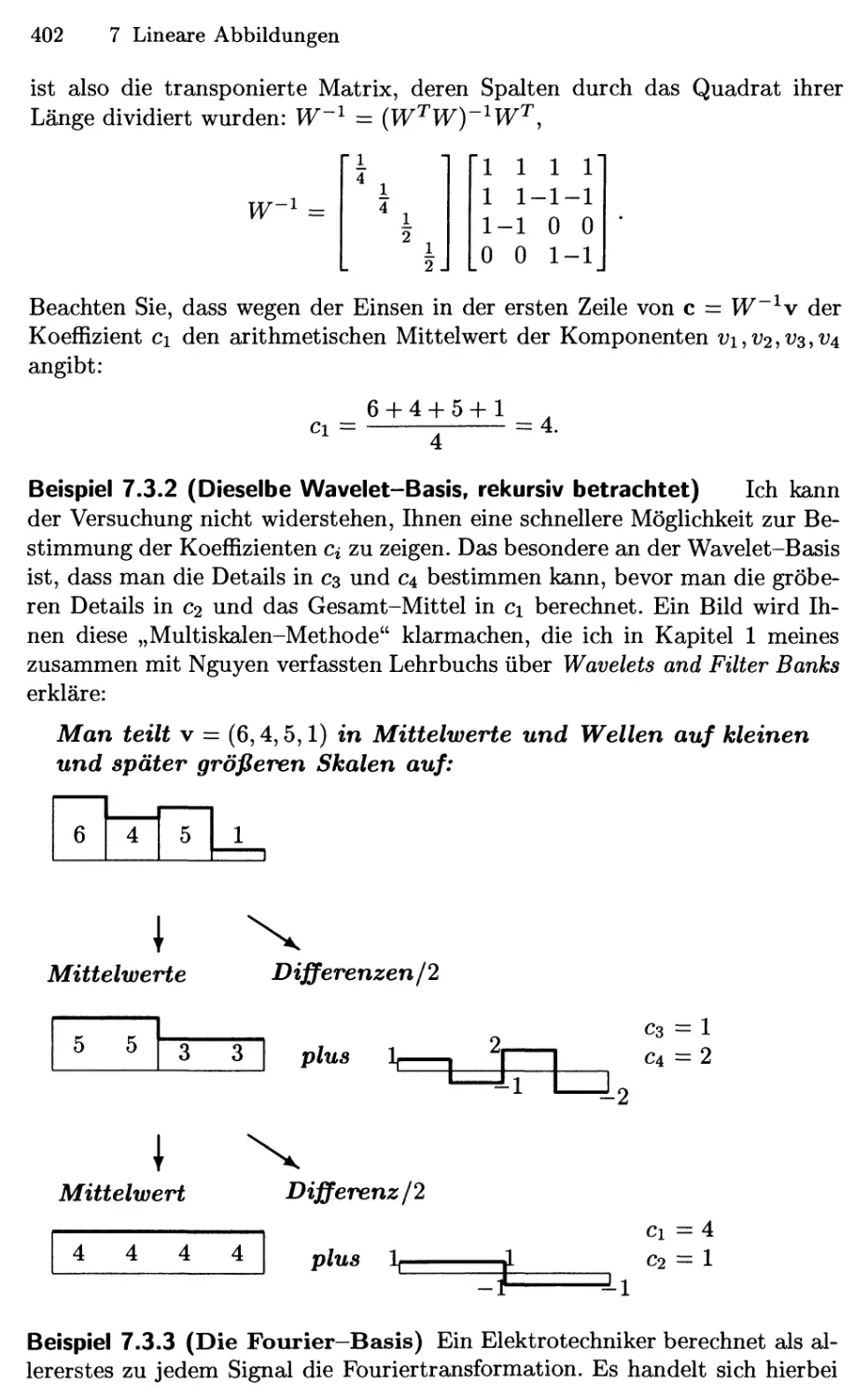

+

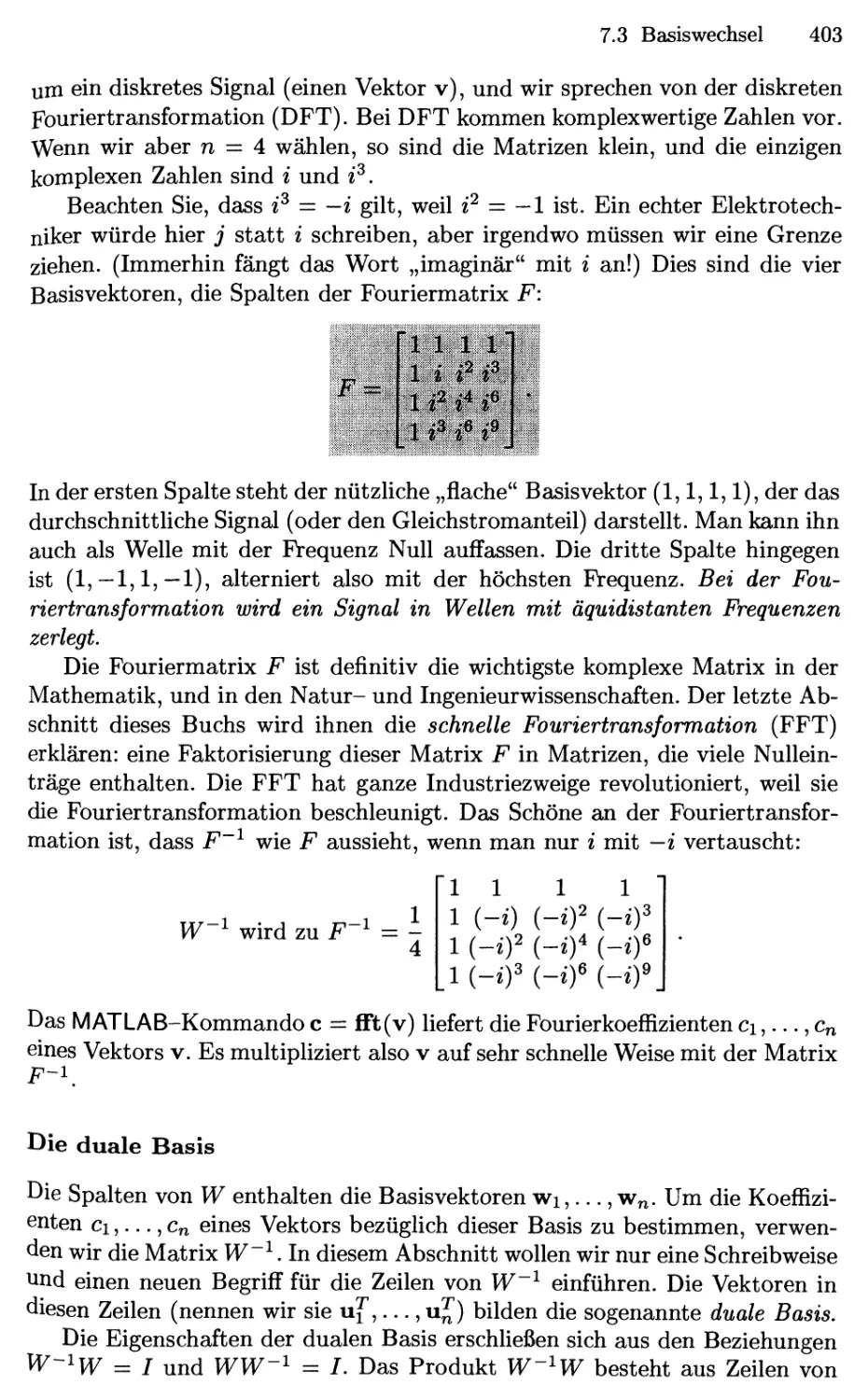

-1

2

=

3'

4

v + w =

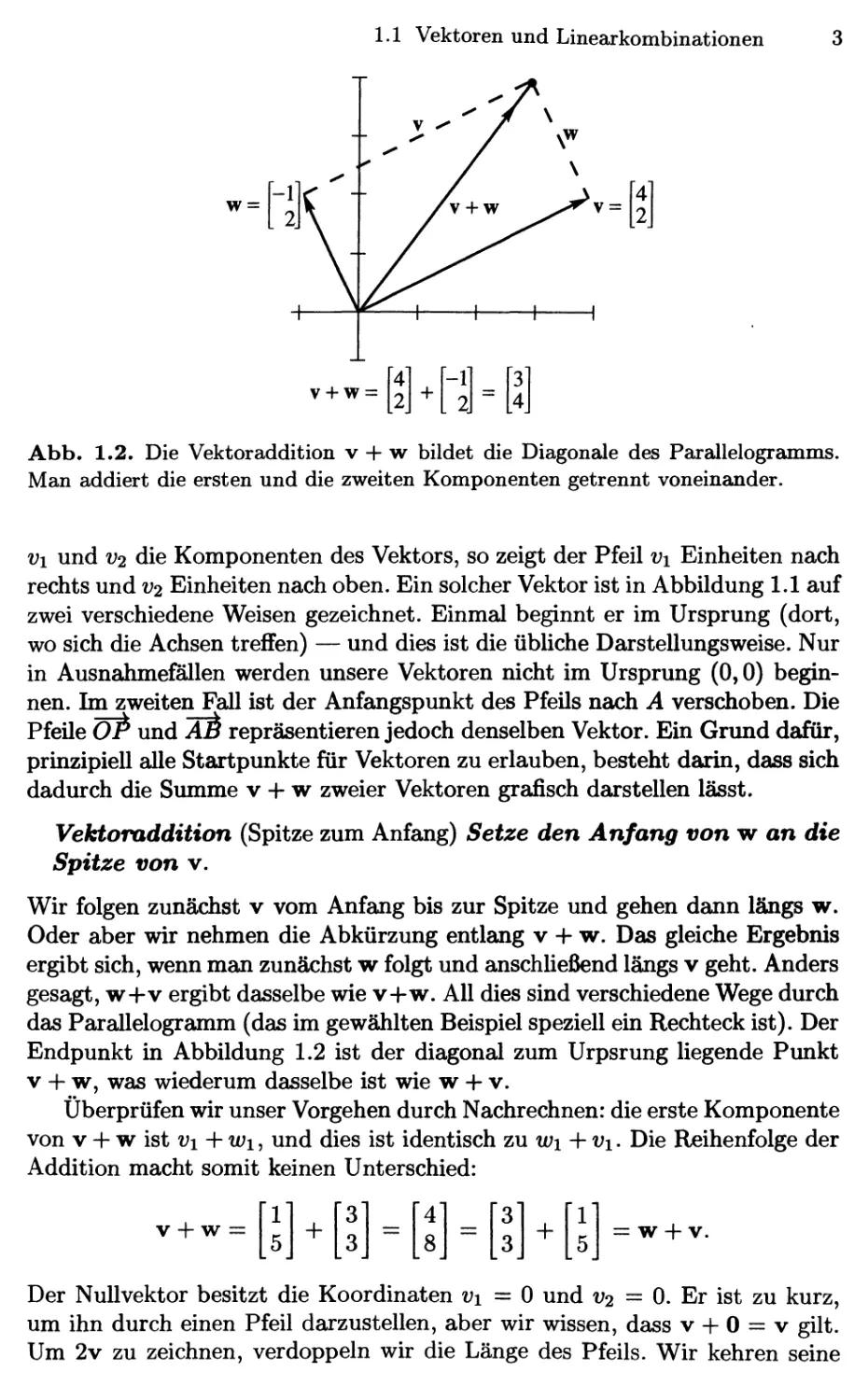

Abb. 1.2. Die Vektoraddition v + w bildet die Diagonale des Parallelogramms.

Man addiert die ersten und die zweiten Komponenten getrennt voneinander.

Vi und V2 die Komponenten des Vektors, so zeigt der Pfeil vi Einheiten nach

rechts und V2 Einheiten nach oben. Ein solcher Vektor ist in Abbildung 1.1 auf

zwei verschiedene Weisen gezeichnet. Einmal beginnt er im Ursprung (dort,

wo sich die Achsen treffen) — und dies ist die übliche Darstellungsweise. Nur

in Ausnahmefallen werden unsere Vektoren nicht im Ursprung @,0)

beginnen. Im zweiten Fall ist der Anfangspunkt des Pfeils nach A verschoben. Die

Pfeile OP und äS repräsentieren jedoch denselben Vektor. Ein Grund dafür,

prinzipiell alle Startpunkte für Vektoren zu erlauben, besteht darin, dass sich

dadurch die Summe v -+- w zweier Vektoren grafisch darstellen lässt.

Vektoraddition (Spitze zum Anfang) Setze den Anfang von w an die

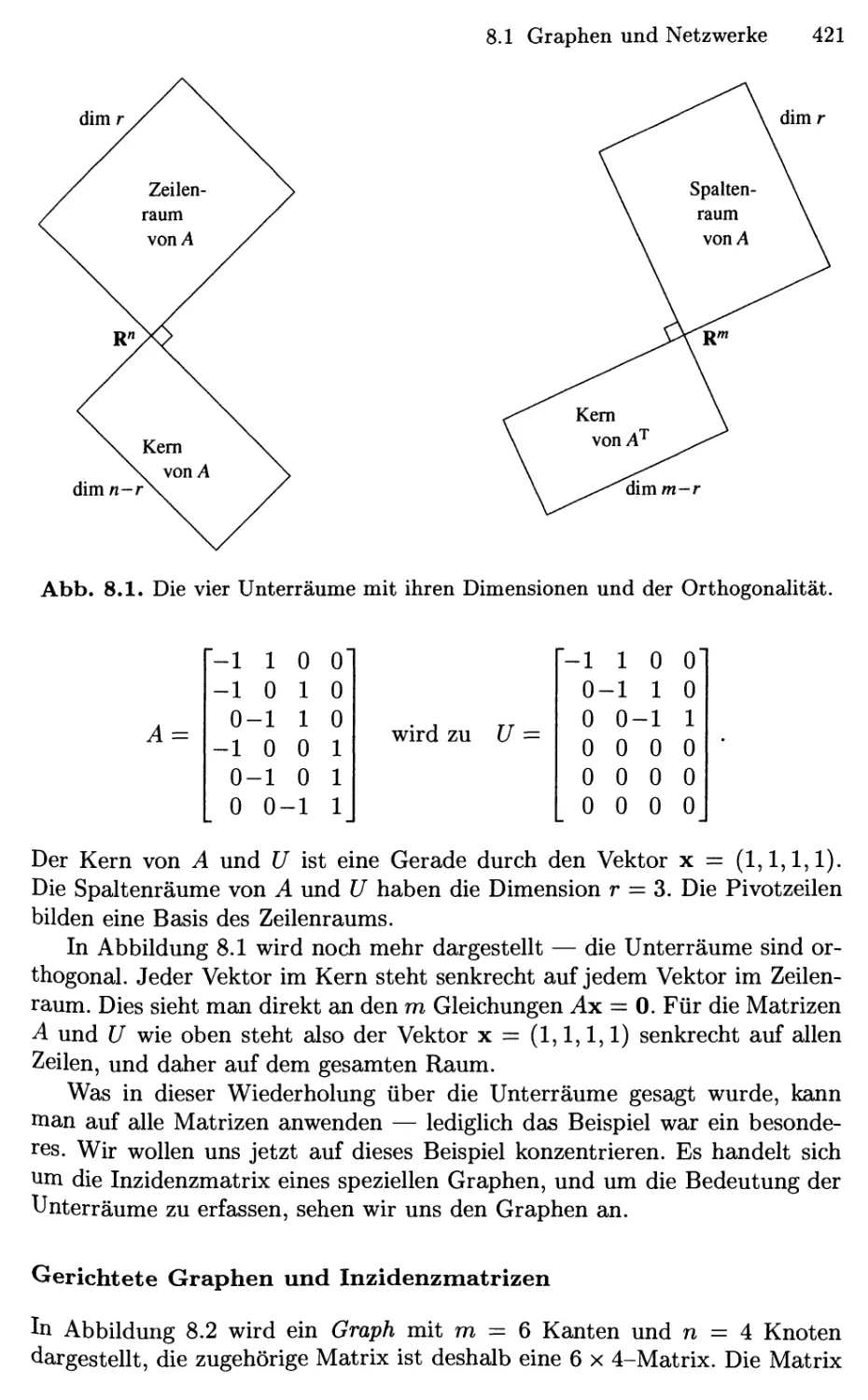

Spitze von v.

Wir folgen zunächst v vom Anfang bis zur Spitze und gehen dann längs w.

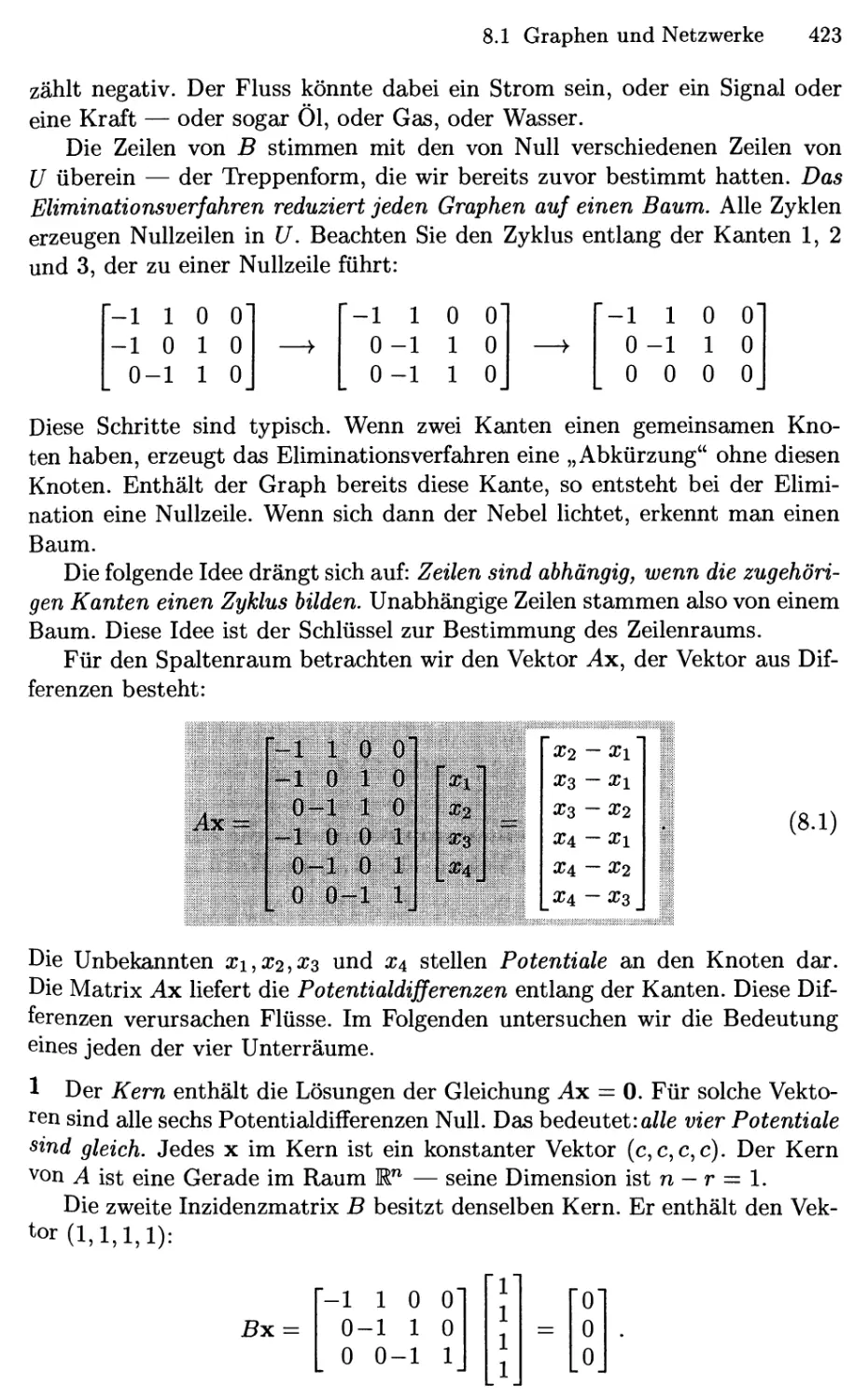

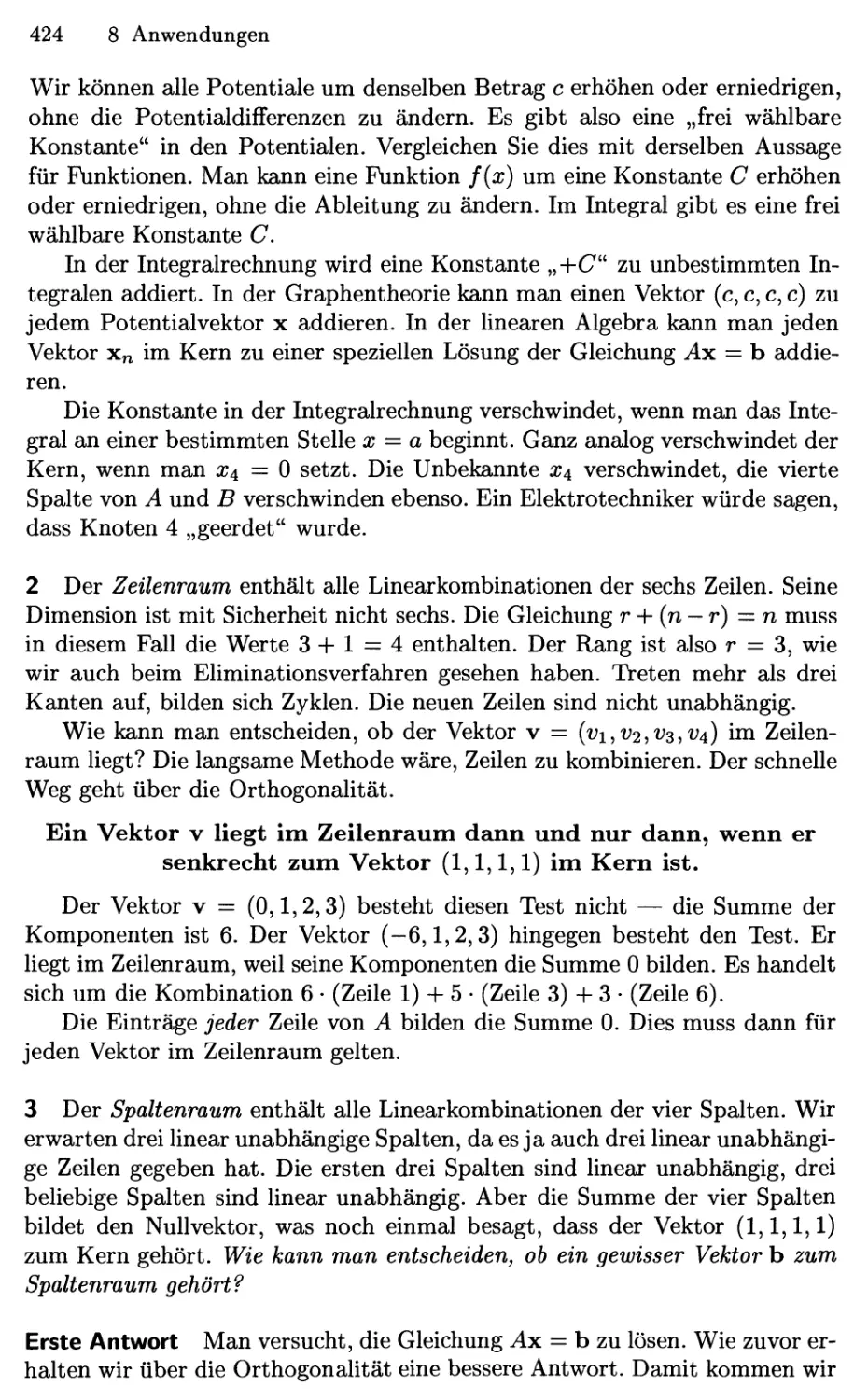

Oder aber wir nehmen die Abkürzung entlang v -+- w. Das gleiche Ergebnis

ergibt sich, wenn man zunächst w folgt und anschließend längs v geht. Anders

gesagt, W-+-V ergibt dasselbe wie v-+-w. All dies sind verschiedene Wege durch

das Parallelogramm (das im gewählten Beispiel speziell ein Rechteck ist). Der

Endpunkt in Abbildung 1.2 ist der diagonal zum Urpsrung liegende Punkt

V -f w, was wiederum dasselbe ist wie w -+- v.

Überprüfen wir unser Vorgehen durch Nachrechnen: die erste Komponente

von V -f w ist i;i -f it;i, und dies ist identisch zu wi-^vi. Die Reihenfolge der

Addition macht somit keinen Unterschied:

V + W :

1

5

+

3

3

—

4

8

—

3

3

-f

[l]

5,

= W -f V.

Der Nullvektor besitzt die Koordinaten i;i = 0 und V2 = 0. Er ist zu kurz,

um ihn durch einen Pfeil darzustellen, aber wir wissen, dass v + 0 = v gilt.

Um 2v zu zeichnen, verdoppeln wir die Länge des Pfeils. Wir kehren seine

4 1 Einführung in die Vektorrechnung

Richtung um, um —v zu erhalten. Diese Umkehrung liefert eine geometrische

Möglichkeit, Vektoren zu subtrahieren.

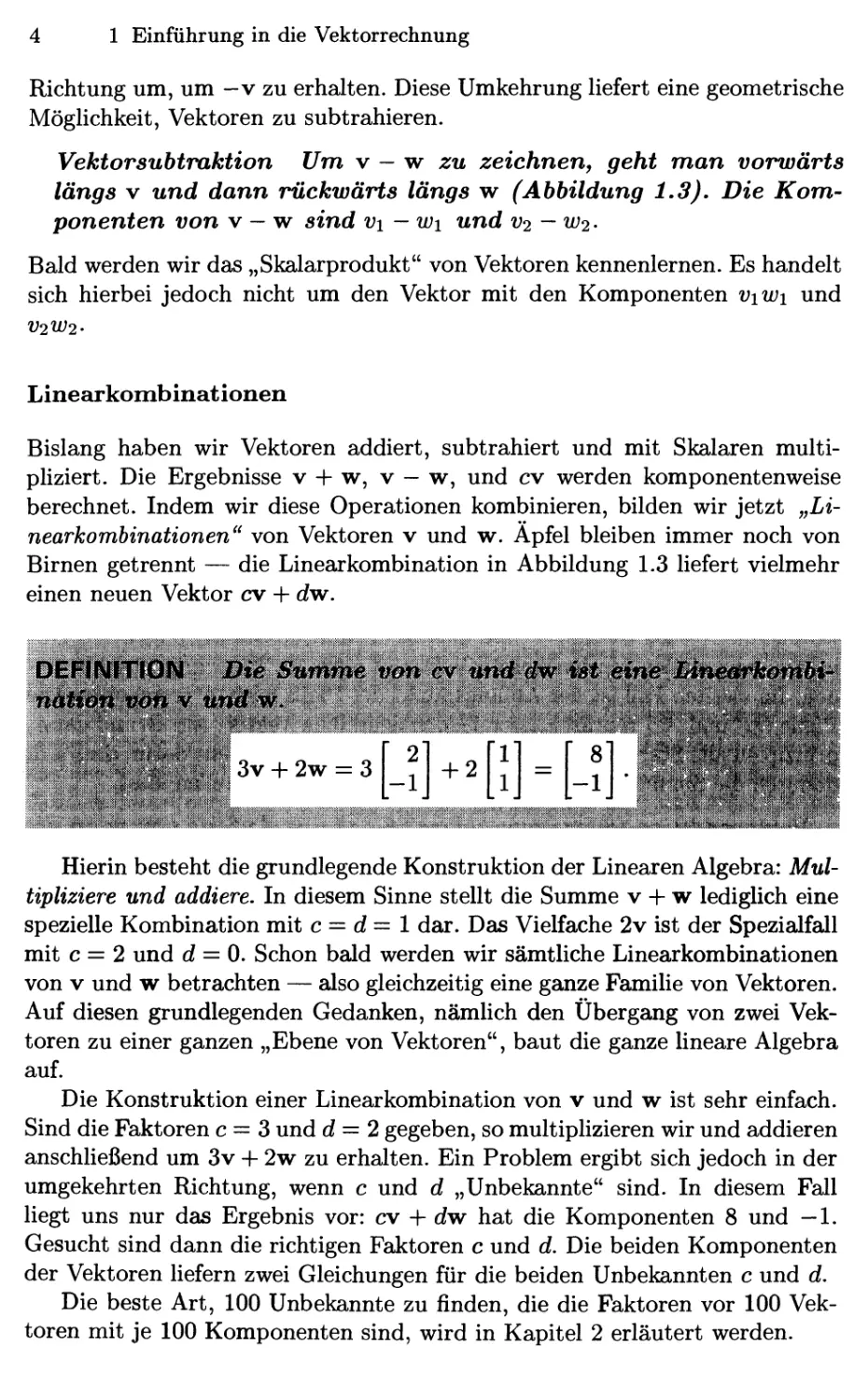

Vektorsubtraktion Um v - w zu zeichnen, geht man vorwärts

längs V und dann rückwärts längs w (Abbildung 1.3). Die

Komponenten von V — w sind vi — wi und V2 —102-

Bald werden wir das „Skalarprodukt" von Vektoren kennenlernen. Es handelt

sich hierbei jedoch nicht um den Vektor mit den Komponenten viWi und

V2W2'

Linearkombinationen

Bislang haben wir Vektoren addiert, subtrahiert und mit Skalaren

multipliziert. Die Ergebnisse v + w, v — w, und cv werden komponentenweise

berechnet. Indem wir diese Operationen kombinieren, bilden wir jetzt

„Linearkombinationen" von Vektoren v und w. Äpfel bleiben immer noch von

Birnen getrennt — die Linearkombination in Abbildung 1.3 liefert vielmehr

einen neuen Vektor cv + dw.

DEANlTtOiyi; BiiSumme t«m cv tit^#«r ifot^

8] ^^wr

' ,,f./^;/V. '-^;.<r ^,^'/ 3v -f 2w = 3

4-2

Hierin besteht die grundlegende Konstruktion der Linearen Algebra:

Multipliziere und addiere. In diesem Sinne stellt die Summe v + w lediglich eine

spezielle Kombination mit c = c? = 1 dar. Das Vielfache 2v ist der Spezialfall

mit c = 2 und d = 0. Schon bald werden wir sämtliche Linearkombinationen

von V und w betrachten — also gleichzeitig eine ganze Familie von Vektoren.

Auf diesen grundlegenden Gedanken, nämlich den Übergang von zwei

Vektoren zu einer ganzen „Ebene von Vektoren", baut die ganze lineare Algebra

auf.

Die Konstruktion einer Linearkombination von v und w ist sehr einfach.

Sind die Faktoren c = 3 und d = 2 gegeben, so multiplizieren wir und addieren

anschließend um 3v + 2w zu erhalten. Ein Problem ergibt sich jedoch in der

umgekehrten Richtung, wenn c und d „Unbekannte" sind. In diesem Fall

liegt uns nur das Ergebnis vor: cv + dw hat die Komponenten 8 und —1.

Gesucht sind dann die richtigen Faktoren c und d. Die beiden Komponenten

der Vektoren liefern zwei Gleichungen für die beiden Unbekannten c und d.

Die beste Art, 100 Unbekannte zu finden, die die Faktoren vor 100

Vektoren mit je 100 Komponenten sind, wird in Kapitel 2 erläutert werden.

1.1 Vektoren und Linearkombinationen

3v + 2w =

-IJ

Abb. 1.3. Vektorsubtraktion v—w (links). Die Linearkombination 3v+2w (rechts).

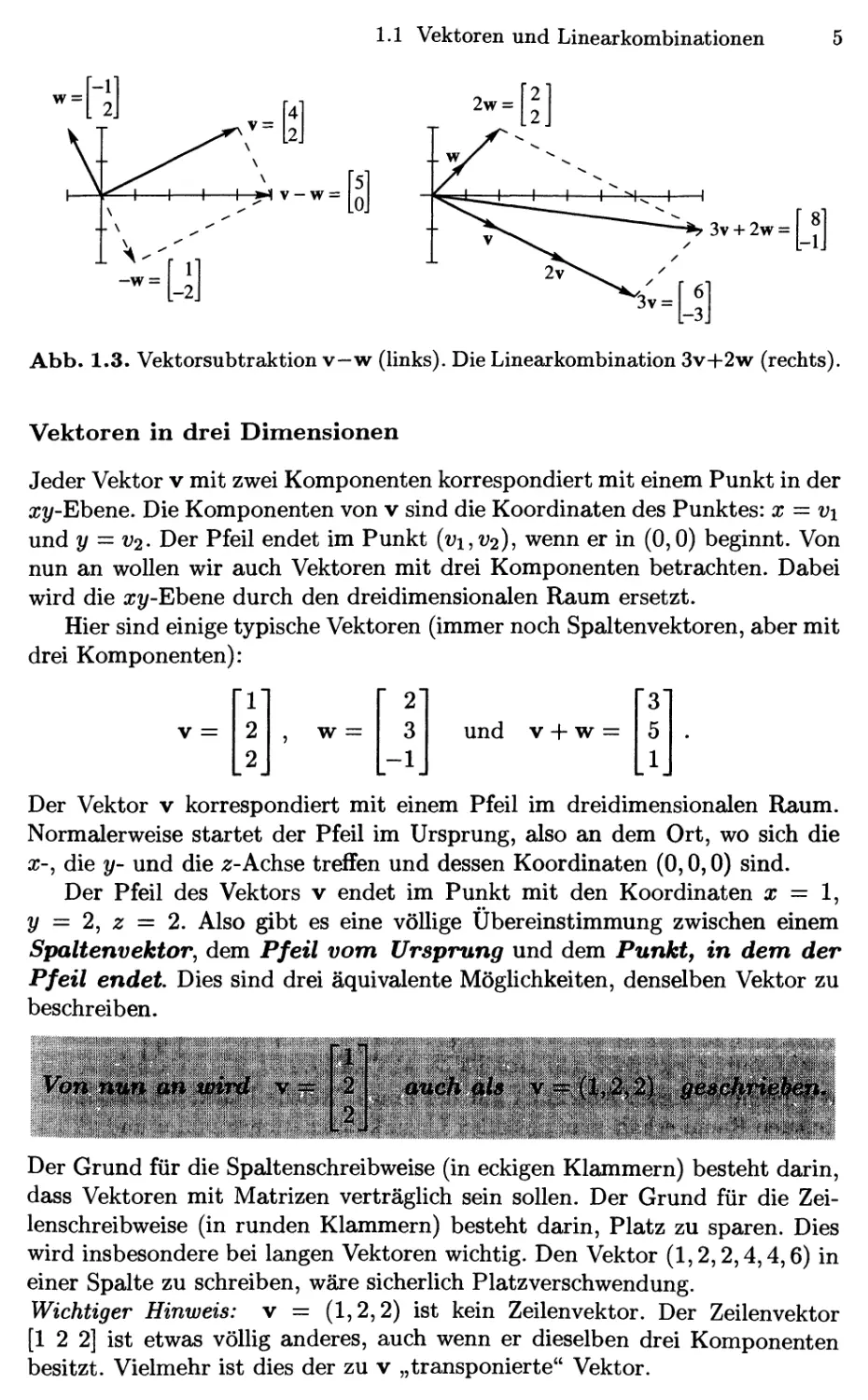

Vektoren in drei Dimensionen

Jeder Vektor v mit zwei Komponenten korrespondiert mit einem Punkt in der

xy-Ehene. Die Komponenten von v sind die Koordinaten des Punktes: x = vi

und y = V2. Der Pfeil endet im Punkt (i;i,i;2M wenn er in @,0) beginnt. Von

nun an wollen wir auch Vektoren mit drei Komponenten betrachten. Dabei

wird die xy-Ehene durch den dreidimensionalen Raum ersetzt.

Hier sind einige typische Vektoren (immer noch Spaltenvektoren, aber mit

drei Komponenten):

V =

rii

2

[2

, w =

2]

3

-ij

und V -f w =

Der Vektor v korrespondiert mit einem Pfeil im dreidimensionalen Raum.

Normalerweise startet der Pfeil im Ursprung, also an dem Ort, wo sich die

X-, die y- und die .2;-Achse treffen und dessen Koordinaten @,0,0) sind.

Der Pfeil des Vektors v endet im Punkt mit den Koordinaten x = 1,

y = 2, z — 2. Also gibt es eine völlige Übereinstimmung zwischen einem

Spaltenvektor, dem Pfeil vom, Ursprung und dem Punkt, in dem, der

Pfeil endet Dies sind drei äquivalente MögUchkeiten, denselben Vektor zu

beschreiben.

..ir

^f^^ms

i

V

"H^\:, ,.^.„^#':{

Der Grund für die Spaltenschreibweise (in eckigen Klammern) besteht darin,

dass Vektoren mit Matrizen verträglich sein sollen. Der Grund für die

Zeilenschreibweise (in runden Klammern) besteht darin, Platz zu sparen. Dies

wird insbesondere bei langen Vektoren wichtig. Den Vektor A,2,2,4,4,6) in

einer Spalte zu schreiben, wäre sicherlich Platzverschwendung.

Wichtiger Hinweis: v = A,2,2) ist kein Zeilenvektor. Der Zeilenvektor

[1 2 2] ist etwas völlig anderes, auch wenn er dieselben drei Komponenten

besitzt. Vielmehr ist dies der zu v „transponierte" Vektor.

6 1 Einführung in die Vektorrechnung

Ein Spaltenvektor kann somit auch horizontal (mit Kommata und runden

Klammern) geschrieben werden. Daher ist A,2,2) tatsächUch ein

Spaltenvektor — er hat sich nur zeitweise hingelegt.

C,2)

A,-2,2)

1 \-y

Abb. 1.4. Vektoren [y] und y korrespondieren mit den Punkten (x^y) und

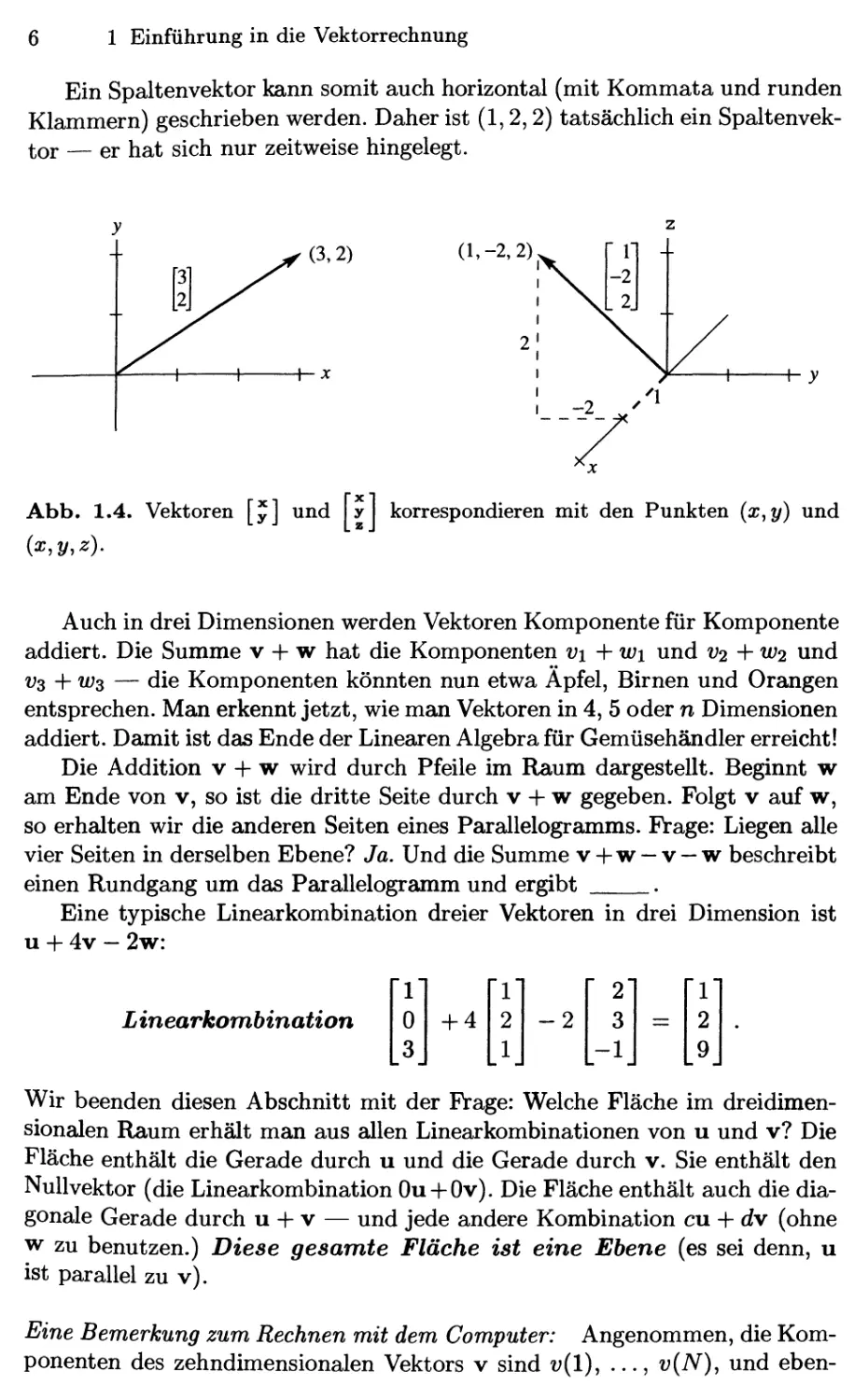

Auch in drei Dimensionen werden Vektoren Komponente für Komponente

addiert. Die Summe v + w hat die Komponenten vi + wi und V2 + W2 und

Vs -\-ws — die Komponenten könnten nun etwa Äpfel, Birnen und Orangen

entsprechen. Man erkennt jetzt, wie man Vektoren in 4, 5 oder n Dimensionen

addiert. Damit ist das Ende der Linearen Algebra für Gemüsehändler erreicht!

Die Addition v + w wird durch Pfeile im Raum dargestellt. Beginnt w

am Ende von v, so ist die dritte Seite durch v + w gegeben. Folgt v auf w,

so erhalten wir die anderen Seiten eines Parallelogramms. Frage: Liegen alle

vier Seiten in derselben Ebene? Ja. Und die Summe v + w — v — w beschreibt

einen Rundgang um das Parallelogramm und ergibt .

Eine typische Linearkombination dreier Vektoren in drei Dimension ist

u + 4v - 2w:

Linearkombination

Wir beenden diesen Abschnitt mit der Frage: Welche Fläche im

dreidimensionalen Raum erhält man aus allen Linearkombinationen von u und v? Die

Fläche enthält die Gerade durch u und die Gerade durch v. Sie enthält den

Nullvektor (die Linearkombination Ou + Ov). Die Fläche enthält auch die

diagonale Gerade durch u + v — und jede andere Kombination cu + dv (ohne

w zu benutzen.) Diese gesamte Fläche ist eine Ebene (es sei denn, u

ist parallel zu v).

Eine Bemerkung zum Rechnen mit dem Computer: Angenommen, die

Komponenten des zehndimensionalen Vektors v sind v{l), ..., v{N), und eben-

1

0

3

+ 4

1

2

1

-2

2

3

-1

=

1

2

9

LI Vektoren und Linearkombinationen 7

so für w. In einer Programmiersprache wie FORTRAN verwendet man eine

Schleife, um die Komponenten einzeln zu addieren:

DO 10 I = 1,N

10 VPLUSW(I) = v(I)+w(I)

MATLAB hingegen arbeitet direkt mit Vektoren und Matrizen. Sind v

und w definiert, dann wird v + w sofort verstanden. Das Ergebnis wird

ausgegeben, falls die Zeile nicht mit einem Semikolon endet. Wir können

Vektoren als Zeilen eingeben — das anschließende Hochkomma ' verwandelt

sie in Spalten. Dann lassen wir v + w und eine andere Linearkombination

ausgeben:

v=[2 3 4]';w=[l 1 l]';u = v + w

2*v - 3*w

Die Summe wird als u = ausgegeben. Die unbenannte Linearkombination

wird mit ans = ausgegeben^:

u = ans =

3 1

4 3

5 5

Die wesentlichen Punkte

l.Ein Vektor v im zweidimensionalen Raum hat zwei Komponenten vi und

2. Vektoren werden Komponente für Komponente addiert und subtrahiert.

3.Das skalare Vielfache ist cv = {cvi,cv2)- Eine Linearkombination von v

und w ist cv -f dw.

4. Sämtliche Linearkombinationen zweier nicht paralleler Vektoren v und w

bilden eine Ebene.

Aufgaben 1.1

Die Aufgaben 1—9 betreffen die Addition von Vektoren und

Linear kombinationen.

1. Zeichnen Sie die Vektoren v= [f] ,w = [2]?^ + ^ ^^^ v — w

gemeinsam in der xy-Ehene.

2. Berechnen und zeichnen Sie die Vektoren v und w, für die gilt v -f w —

[f] und v-w= [l].

3. Bestimmen Sie die Komponenten von 3v -h w, v - 3w und cv + dw für

die Vektoren v = [ J] und w = [l].

^ für engl, „answer" = „Antwort", Anm. d. Ubers.

8 1 Einführung in die Vektorrechnung

4. Berechnen Sie u + v, u + v + w und 2u + 2v + w für die Vektoren

u =

ri"

2

I3

, v =

"-3"

1

-2

, W=:

2]

-3

-ij

5. Die Komponenten jeder Linearkombination von v = A, —2,1) und w =

@,1,-1) addieren sich zu auf. Bestimmen Sie c und d, so dass

cv-\-dw = D, 2, -6) gilt.

6. Zeichnen Sie die folgenden neun Linear kombinat ionen in der x^z-Ebene:

+ d

mit c = 0,l,2 und d = 0,1,2.

7. (a) Die Subtraktion v — w geht vorwärts längs v und rückwärts längs w.

In der Abbildung 1.3 ist auch ein zweiter Weg zu v — w aufgezeigt.

Welcher ist es?

(b) Wenn Sie alle Kombinationen von v und w betrachten, welche

„Vektorenfläche" erhalten Sie?

8. Das Parallelogramm in Abbildung 1.2 hat die Diagonale v -h w. Wie

ist seine andere Diagonale darstellbar? Was ergibt die Summe beider

Diagonalen? Zeichnen Sie diese Vektorsumme.

9. Wenn ein Parallelogramm die drei Ecken A,1), D,2), und A,3) besitzt,

welche möglichen vierten Ecken gibt es? Zeichnen Sie zwei davon.

In den Aufgaben 10—13 geht es um die Länge von Vektoren.

Rechnen Sie mit der Formel (Länge von v)^ = i;^ _^ i;|.

10. Das Parallelogramm mit den Seiten v = D,2) und w = (—1,2) ist ein

Rechteck (vgl. Abbildung 1.2). Überprüfen Sie den Satz des Pythagoras

a^ + &2 _ ^2^ ^gj. yj^^ yr^^ Dreiecke mit rechtem Winkel gilt:

{hBägß Von y)^ ^ (h^ge von w)^ Ä (Linge YpE vf^;w)^*

11. Im rechtwinkligen Fall funktioniert die Formel a^-\-P = (? auch für v—w.

Überprüfen Sie in Abbildung 1.2, dass

(Länge von v)^ + (Länge von w)^ = (Länge von v — w)^

gilt. Finden Sie ein Beispiel für v und w (nicht rechtwinklig) für die diese

Formel falsch ist.

12. Um zu betonen, dass rechtwinklige Dreiecke besondere Dreiecke

darstellen, bestimmen Sie Vektoren v und w, die keinen Winkel von 90°

miteinander bilden. Vergleichen Sie nun (Länge von v)^ -h (Länge von w)^

mit (Länge von v -}- w)^.

1.1 Vektoren und Linearkombinationen 9

13. Überprüfen Sie in Abbildung 1.2 dass (Länge von v) + (Länge von w)

größer ist als (Länge von v + w). Diese „Dreiecksungleichung" ist für

jedes Dreieck richtig, ausgenommen das absolut dünne Dreieck, in dem v

und w sind. Beachten Sie, dass die Längen hier nicht quadriert

werden.

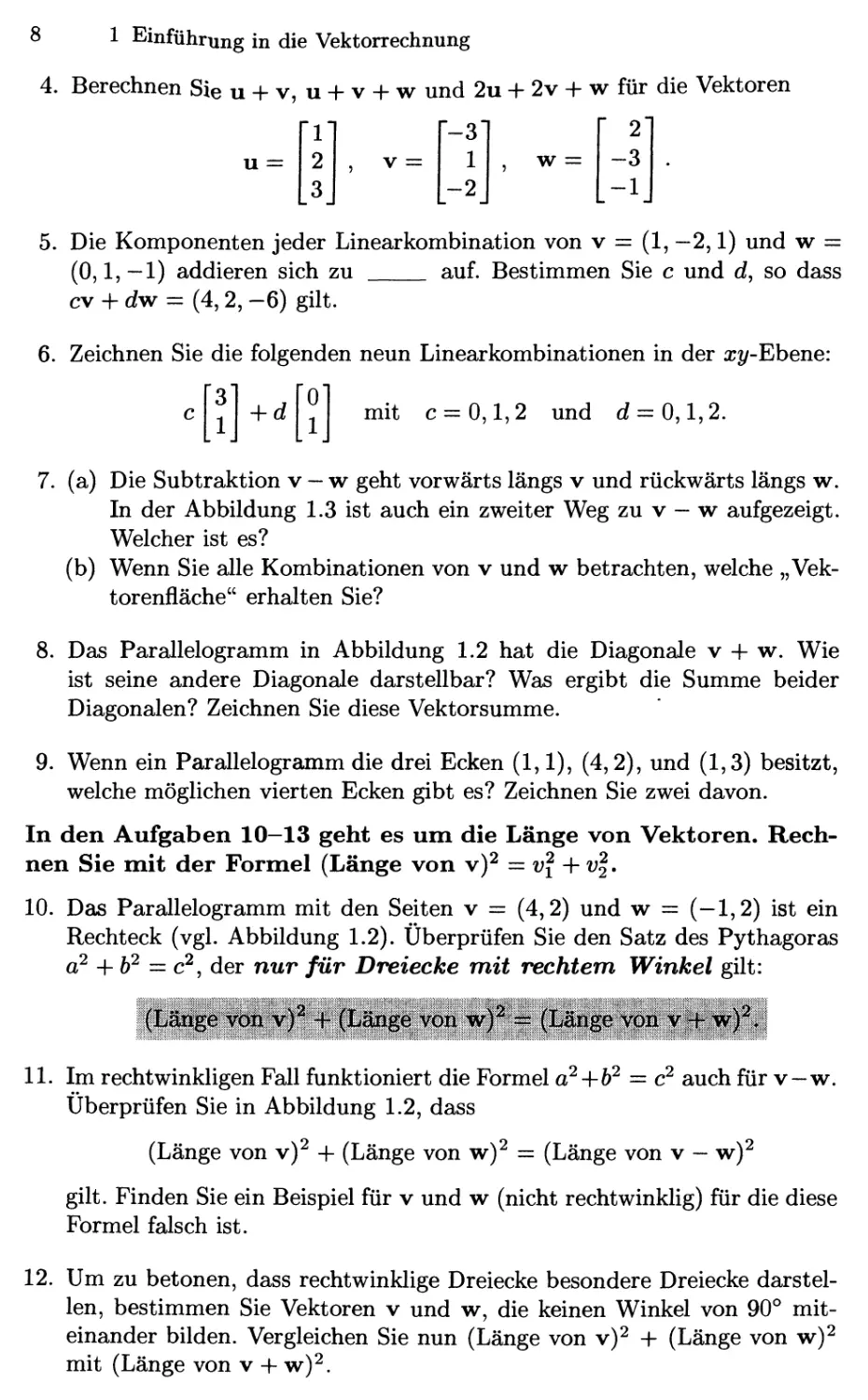

@,0,1)

7 @,1,0)

A,0,0)

4:00

In den Aufgaben 14—18 geht es um spezielle Vektoren in Würfeln

und Uhren.

14. Zeichnen Sie den Würfel ab, und bestimmen Sie die Vektorsumme von

i = A,0,0), j = @,1,0) und k = @,0,1) grafisch. Die Summe i-fj ergibt

die Diagonale von .

15. Drei Kanten des Einheitswürfels sind i,j und k. Drei Ecken sind @,0,0),

A,0,0) und @,1,0). Welches sind die anderen fünf Ecken, und was sind

die Koordinaten des Mittelpunktes? Die Mittelpunkte der sechs Flächen

des Würfels sind .

16. Wie viele Ecken hat ein Würfel in 4 Dimensionen? Wie viele Flächen?

Wie viele Kanten? Eine typische Ecke ist @,0,1,0).

17. (a) Was ist die Summe V der zwölf Vektoren, die vom Mittelpunkt einer

Uhr zu den Zeiten 1:00 Uhr, 2:00 Uhr, ..., 12:00 Uhr zeigen?

(b) Bestimmen Sie die Summe der verbleibenden elf Vektoren, wenn der

Vektor zu 4:00 Uhr herausgenommen wird.

(c) Nehmen Sie an, der 1:00-Uhr-Vektor sei halbiert. Addieren Sie ihn zu

den anderen elf Vektoren.

18. Nehmen Sie an, die zwölf Vektoren beginnen nicht in der Mitte bei @,0),

sondern in @, -1) am unteren Ende der Uhr. Dann ist der Vektor zu 6:00

Uhr der Nullvektor, und der Vektor zu 12:00 Uhr wird zu Bj) verdoppelt.

Summieren Sie die zwölf auf diese Weise konstruierten Vektoren auf.

10 1 Einführung in die Vektorrechnung

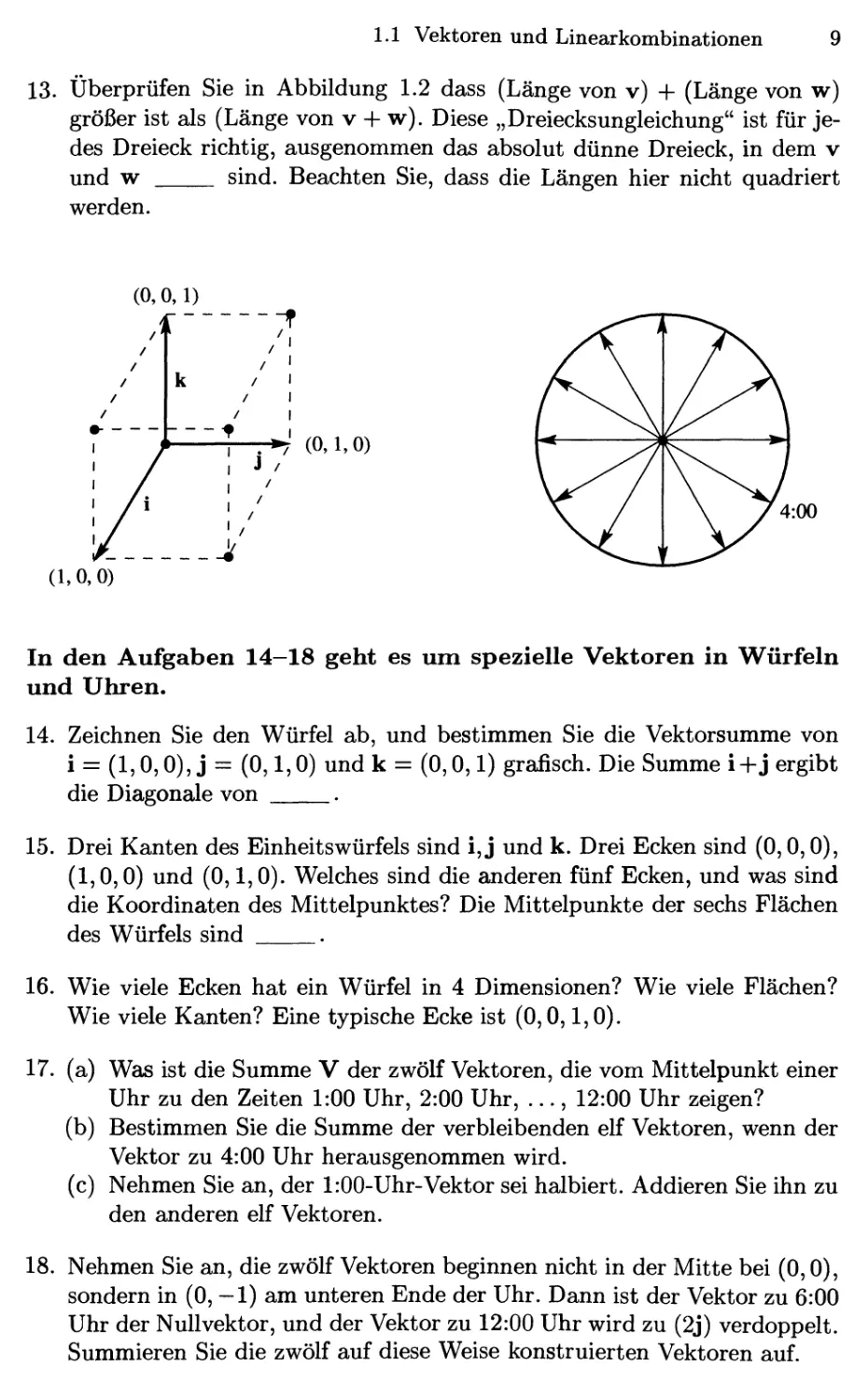

Aufgaben 19—22 in einer Ebene Aufgaben 23—27 im dreidimensionalen Raun

Die Aufgaben 19—22 behandeln Linearkombinationen von v und w

(siehe Abbildung).

19. Die Abbildung zeigt den Vektor u =

|v + ^w, ^v + |w und V + w ein.

|v + |w. Zeichnen Sie die Punkte

20. Markieren Sie die Punkte — v + 2w und einer weiteren Linearkombination

cv + dw mit c+d= 1. Zeichnen Sie die Gerade aller Linearkombinationen

mit c -h d = 1.

21. Bestimmen Sie |v + ^w und |v -f- |w. Auf welcher Geraden liegen die

Kombinationen cv -h cw? Welchen Strahl erzeugen die Kombinationen für

c = d mit der Einschränkung c > 0?

22. (a) Zeichnen Sie die Vektoren |v + w und v + |w. Schraffieren Sie den

Bereich, den die Vektoren cv -h dw mit 0 < c < 1 und 0 < d < 1

ausfüllen,

(b) Zeichnen Sie den „Kegel" aller Kombinationen cv + dw mit 0 < c

und 0 < d.

In den Aufgaben 23 — 27 geht es um Vektoren u, v und w im

dreidimensionalen Raum (siehe Abbildung).

23. (a) Wo liegen |u -h |v -h |w und |u + |w in der Abbildung?

(b) Eine kleine Herausforderung: Unter welchen Bedingungen an c, d und

e stellen die Vektoren cu + dv -h ew die Ebene dar, in der die Spitzen

von u, V und w liegen?

24. Die drei Seiten des gestrichelten Dreiecks sind v—u, w—v und u—w. Ihre

Summe ist . Zeichnen Sie die Spitze-Anfang-Summe des ebenen

Dreiecks C,1) plus (-1,1) plus (-2, -2).

1.2 Längen und Skalaxprodukte 11

25. Schraffieren Sie die Pyramide aus den Linear kombinationen cu + dv + e w

mit c > 0, d > 0, e > 0 und c + d + e < 1. Liegt der Vektor |(u + v +w)

innerhalb oder außerhalb der Pyramide?

26. Gibt es einen Vektor, der nicht als Linearkombination cu + dv + ew

dargestellt werden kann, wenn man alle Kombinationen von u, v und w

zulässt?

27. Welche Vektoren liegen gleichzeitig in der u-v-Ebene und in der v-w-

Ebene?

28. (a) Zeichnen Sie Vektoren u, v und w so, dass ihre Linearkombinationen

cu + dv + ew auf nur einer Geraden liegen,

(b) Zeichnen Sie Vektoren u, v und w so, dass ihre Linearkombinationen

cu + dv + ew lediglich eine Ebene ausfüllen.

29. Welche Kombination der Vektoren

1

2

und

3

1

erzeugt

14"

8j

?

Formulieren Sie diese Frage in Form von zwei Gleichungen für die Koeffizienten

c und d in der Linearkombination.

1.2 Längen und Skalarprodukte

Im ersten Abschnitt wurde die Multiplikation von Vektoren zwar erwähnt,

jedoch nicht weiter verfolgt. Wir werden jetzt hierauf genauer eingehen und

das „Skalarprodukt" von Vektoren v und w definieren. In dieser

Multiplikation tauchen wohl die beiden einzelnen Produkte der Komponenten viWi

und V2W2 auf, damit ist aber noch nicht Schluss. Denn diese beiden Zahlen

werden zudem addiert und ergeben eine einzige Zahl v-w.

Beispiel 1.2.1 Das Skalarprodukt der Vektoren v - D,2) und w = (-1,2)

ist Null:

-1

2

= -4-h4 = 0.

Null ist in der Mathematik stets eine besondere Zahl. Bei Skalarprodukten

bedeutet das Auftreten der Null, dass die beiden Vektoren senkrecht

zueinander stehen. Der Winkel zwischen ihnen ist 90°. Als wir die Vektoren in

12 1 Einführung in die Vektorrechnung

Abbildung 1.2 gezeichnet haben, sahen wir ein Rechteck — nicht nur

irgendein Parallelogramm. Das einfachste Beispiel rechtwinkliger Vektoren ist das

Paar i = (i, 0) längs der x-Achse und j = @,1) längs der ^/-Achse. Auch hier

ist das Skalarprodukt i-j =: 0 + 0 = 0 und die Vektoren i und j bilden einen

rechten Winkel.

Die Vektoren v = A,2) und w = B,1) stehen nicht senkrecht

aufeinander. Ihr Skalarprodukt ist 4. Bald wird es uns dieser Wert ermöglichen, den

Winkel zwischen ihnen anzugeben (der nicht 90° ist).

Beispiel 1.2.2 Wir legen ein Gewicht 4 an den Punkt x = —1 und das

Gewicht 2 an den Punkt x = 2. Wäre die x-Achse eine Wippe mit Mittelpunkt

X = 0, würden sich die Gewichte ausbalancieren, denn das Skalarprodukt ist

D)(-l) + B)B) = 0.

Dies ist ein typisches Beispiel aus den Ingenieur- und

Naturwissenschaften. Der Gewichts-Vektor ist {wi,W2) = D,2), der Abstandsvektor (^1,^2) =

(—1,2). Kraft mal Abstand, Wi mal vi, ergibt das „Drehmoment" des ersten

Gewichtes. Die Gleichung, die das Gleichgewicht der Wippe beschreibt, ist

durch wivi -i- W2V2 = 0 gegeben.

Das Skalarprodukt wv ist gleich vw.

Die Reihenfolge von v und w ist somit unwichtig.

Beispiel 1.2.3 Man begegnet Skalarprodukten auch in den

Wirtschaftswissenschaften und im Geschäftsalltag. Stellen wir uns vor, wir hätten fünf

Produkte, die wir kaufen oder verkaufen. Die Preise seien {pi,P2,P3,P4,P5) für

jeweils eine Einheit des jeweiligen Produktes — dies ergibt den „Preisvektor"

p. Die Mengen, die wir ein- oder verkaufen, seien (^1 ,q2,Q3,Q4,Qb) — positiv

für den Verkauf, negativ im Falle des Einkaufs. Wenn wir qi Einheiten des

ersten Produktes zum Preis pi verkaufen, bringt das Einnahmen in Höhe von

qiPi. Die Gesamteinnahmen ergeben sich dann aus dem Skalarprodukt q-p:

Einnahmen = (^1, ^2, • • •, ^5)-(pi,P2, • • • ,^5) = qiPi + ^2^2 + • • • + q^Pb-

Ist das Skalarprodukt Null, so bedeutet dies, dass die Bilanz ausgeghchen

ist — die Gesamteinnahmen sind gleich den Gesamtausgaben, falls q-p = 0

gilt. In diesem Falle steht der Vektor p senkrecht auf dem Vektor q (und zwar

im fünfdimensionalen Raum). Für fünf Produkte sind die Vektoren fünf-

dimensional. Durch Beispiele dieser Art wird man in der linearen Algebra

sehr schnell in hohe Dimensionen geführt.

Noch ein kleiner Hinweis: Tabellenkalkulationen sind im Geschäftsleben

zu unverzichtbaren Hilfsmitteln geworden. Was ist eine Tabellenkalkulation

eigentlich? In ihr werden Linearkombinationen und Skalarprodukte

berechnet, und was man auf dem Computerbildschirm sieht, ist nichts anderes als

eine Matrix.

1.2 Längen und Skalaxprodukte 13

Merkregel: Um das Skalarprodukt auszurechnen, multipliziert man jedes Vi

mit Wi, und addiert die Einzelprodukte auf.

Längen und Einheitsvektoren

Ein wichtiger Fall ist das Skalarprodukt eines Vektors mit sich selbst, wenn

V = w gilt. Das Skalarprodukt des Vektors v = A,2,3) mit sich selbst ist

vv = 14:

v-v =

rr

2

[_3

•

"

2

3j

= 1 + 4 + 9 = 14.

Das Ergebnis ist nicht Null, weil v nicht senkrecht zu sich selbst steht.

Anstelle eines 90°-Winkels haben wir einen 0°-Winkel. In diesem Spezialfall

ergibt das Skalarprodukt v-v das Quadrat der Länge.

iiSfö^^Sevonv = ||v|| =

Im Zweidimensionalen ist die Länge durch Vv^ + v^ gegeben, in drei

Dimensionen durch Vvf +V2+ v^. Entsprechend der Rechnung oben hat v =

A,2,3) die Länge ||v|| = >/l4.

@,2)

1,2,3) hat Länge \/l4

@,2,0)

A,0,0)^ ^^'^A,2,0) hat Länge y/E

Abb. 1.5. Die Länge y/v-yr zwei- und dreidimensionaler Vektoren.

Diese Definition lässt sich plausibel machen. ||v|| ist einfach die ganz

normale Länge eines Pfeiles, der den Vektor darstellt. Im Zweidimensionalen

liegt der Pfeil in einer Ebene und ist dort die dritte Seite eines

rechtwinkligen Dreiecks, dessen andere Seitenlängen durch die Komponenten des Vektors

14

1 Einführung in die Vektorrechnung

gegeben sind, zum Beispiel 1 und 2 für den Vektor v — A,2). Die drei

Seitenlängen sind über die Formel a^ + fe^ = (? miteinander verbunden, d.h., es

giltl2 + 22 = ||v|p.

Um die Länge von v = A,2,3) zu bestimmen, benutzen wir den Satz

des Phythagoras zweimal. Zunächst hat der Vektor in der x — ^/-Ebene die

Komponenten 1,2,0 und die Länge \/5. Dieser Vektor steht senkrecht auf

dem Vektor @,0,3), der gerade nach oben zeigt. Deswegen hat die Diagonale

des gestrichelten Quaders die Länge ||v|| = \/5 + 9 = \f\Ä.

Die Länge eines vierdimensionalen Vektors wäre \/v\ -^ v\ -\- v\ -\' v\. So

hat zum Beispiel A,1,1,1) die Länge \/\^ -f P -f 1^ + 1^ — 2, gerade die

Länge der Diagonalen durch einen Einheitswürfel im vierdimensionalen Raum.

Die Diagonale in n Dimensionen hat die Länge yjn.

Das Wort „Einheits-" bedeutet immer, dass irgendein Maß gleich eins ist.

Der Einheitswürfel hat zum Beispiel Seiten der Länge eins. Ein Einheitskreis

hat den Radius eins. Nun können wir auch die Idee eines „Einheitsvektors"

einführen.

;A ... f i. ^<'^.^yy^ ,

Ein vierdimensionales Beispiel ist u = (|, |, |, ^), dessen Skalarprodukt u-u

gerade ^ + ^ + ^ + ^ = 1 ist. Wir haben den Vektor v = A,1,1,1) durch

seine Länge ||v|| = 2 dividiert, um diesen Vektor zu erhalten.

Beispiel 1.2.4 Die Standardeinheitsvektoren längs der x- und der ^/-Achse

werden mit i und j bezeichnet. Der Einheitsvektor in der x^/—Ebene, der mit

der X-Achse einen Winkel d bildet, ist durch (cos ö, sin ö) gegeben:

1 =

und j

und u =

cos^

sinö

Für ^ = 0 wird der Vektor u gerade zu i. Falls d — 90° (oder | im Bogenmaß),

ist u derselbe Vektor wie j. Aber für jeden Winkel ergeben die Komponenten

cos^ und sinö gerade u-u = 1, weil cos^^ + sin^^ = 1 gilt. Diese Vektoren

zeigen zu den Punkten auf dem Einheitskreis in Abbildung 1.6. Also sind cosö

und sin Q ganz einfach die Koordinaten des Punktes auf dem Einheitskreis mit

zugehörigem Winkel d.

In drei Dimensionen sind i, j und k die Einheitsvektoren längs der drei

Koordinatenachsen. Ihre Komponenten sind A,0,0), @,1,0) und @,0,1).

Beachten Sie, dass jeder dreidimensionale Vektor eine Linearkombination von i,

j und k ist. Der Vektor v — B,2,1) ist zum Beispiel gleich 2i + 2j + k, seine

Länge ist \/22-h22-hl2, also ||v|| = 3.

1.2 Längen und Skalarprodukte 15

i+j = (l,l) J

u=A,1)/n/2

= A,0)

Abb. 1.6. Die Koordinatenvektoren i und j. Der Einheitsvektor u im Winkel von

45° (links) und der Einheitsvektor (cos ^, sin ^) im Winkel 0.

Da B,2,1) die Länge 3 hat, hat der Vektor (|, |, |) die Länge 1. Um

einen Einheitsvektor zu erzeugen, dividiert man einfach v durch seine Länge

Im Dreidimensionalen haben wir so u = (|, |, |) gefunden. Rechnen Sie

nach, dass u-u =|-j~|-j~| = l gilt. Es zeigt also u auf einen Punkt der „Ein-

heitskugel" mit Mittelpunkt im Ursprung. Einheitsvektoren korrespondieren

generell mit Punkten auf der Kugel mit Radius eins.

Der Winkel zwischen zwei Vektoren

Wir haben schon erwähnt, dass für rechtwinklige Vektoren vw = 0 gilt.

Das Skalarprodukt ist null, wenn der Winkel zwischen den Vektoren 90° ist.

Um dies zu begründen, müssen wir rechte Winkel mit Skalarprodukten in

Verbindung bringen. Das wird uns darauf bringen, wie uns v-w den Winkel

zwischen zwei beliebigen Vektoren (ungleich dem Nullvektor) liefert.

%i^^.):.. :f' \:;A- ''X'' ';i/'';'r:h;-/'^ '^'':ä;'- '-<''}-;"". "f;"' y^f'by'i^^i^" 1^f''''.i'=

Beweis. Wenn v und w zueinander rechtwinklig stehen, bilden sie zwei

Seiten eines rechtwinkligen Dreiecks. Die dritte Seite (die Hypotenuse, die in

Abbildung 1.7 von links nach rechts geht) ist dann v — w. Damit wird aus

der Gleichung a^ + 6^ = c^ für die Seitenlängen

16

1 Einführung in die Vektorrechnung

||v|p + ||w|p = ||v - w|p (für senkrechte Vektoren).

A.2)

Schreibt man die Formeln für die Längen in zwei Dimensionen aus, wird

daraus

vl^V2+wf + wl

{Vi -WiY + {V2 - W2Y

A.3)

Nach Ausmultiplikation fängt die rechte Seite mit v\ — 2viWi + w\ an.

Deswegen kann man auf beiden Seiten der Gleichung vi und w\ subtrahieren.

Genauso enthält {v2 —^2)^ die Terme v^ und w^ sowie —2v2W2' Subtrahiert

man wieder auf beiden Seiten, bleiben nur noch —2viWi und —2v2W2 übrig.

(In drei Dimensionen hätte man außerdem noch —2vsw^.) Im letzten Schritt

dividiert man durch -2 und erhält:

0 = —2viWi — 2V2W2 und daher viwi -\-v2W2 = 0.

A.4)

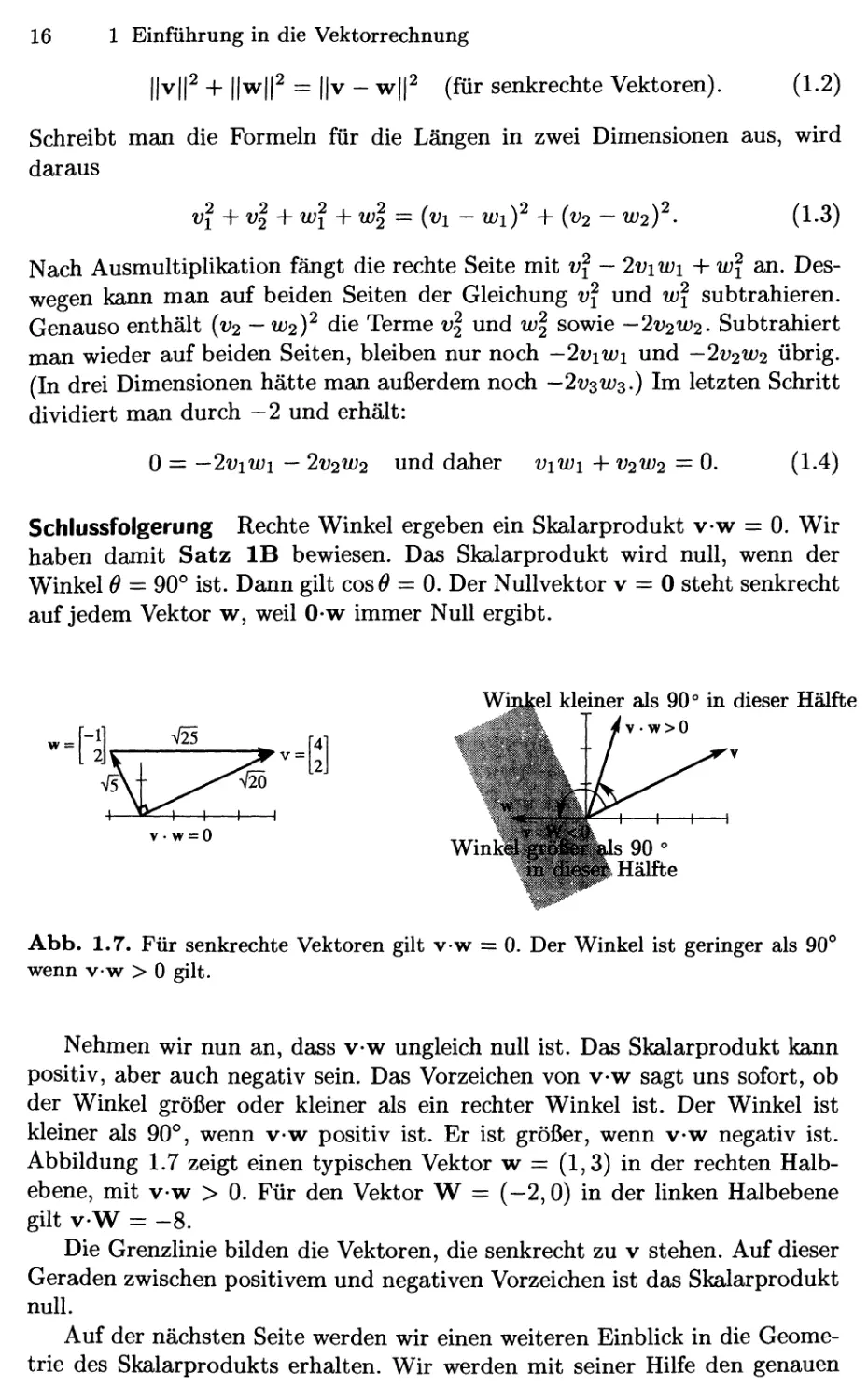

Schlussfolgerung Rechte Winkel ergeben ein Skalarprodukt v-w = 0. Wir

haben damit Satz IB bewiesen. Das Skalarprodukt wird null, wenn der

Winkel 0 = 90° ist. Dann gilt cosO = 0. Der Nullvektor v = 0 steht senkrecht

auf jedem Vektor w, weil 0-w immer Null ergibt.

•=[1,

V25

VsN

V • W=:0

V2Ö

-0

^—I—I-

WinM;

kleiner als 90° in dieser Hälfte

Abb. 1.7. Für senkrechte Vektoren gilt vw = 0. Der Winkel ist geringer als 90°

wenn vw > 0 gilt.

Nehmen wir nun an, dass v-w ungleich null ist. Das Skalarprodukt kann

positiv, aber auch negativ sein. Das Vorzeichen von v-w sagt uns sofort, ob

der Winkel größer oder kleiner als ein rechter Winkel ist. Der Winkel ist

kleiner als 90°, wenn v-w positiv ist. Er ist größer, wenn v-w negativ ist.

Abbildung 1.7 zeigt einen typischen Vektor w = A,3) in der rechten

Halbebene, mit v-w > 0. Für den Vektor W = (-2,0) in der linken Halbebene

gilt V-W = -8.

Die Grenzlinie bilden die Vektoren, die senkrecht zu v stehen. Auf dieser

Geraden zwischen positivem und negativen Vorzeichen ist das Skalarprodukt

null.

Auf der nächsten Seite werden wir einen weiteren Einbhck in die

Geometrie des Skalarprodukts erhalten. Wir werden mit seiner Hilfe den genauen

1.2 Längen und Skalaxprodukte 17

Winkel 6 bestimmen. Dies ist eigentlich nicht notwendig für die lineare

Algebra, Sie könnten hier aufhören zu lesen! Denn haben wir erst einmal Matrizen

und lineare Gleichungen erreicht, so werden wir dem 9 den Rücken kehren.

Aber da es in diesem Abschnitt noch um Winkel geht, ist dies die richtige

Stelle, um die Formel einzuführen, Sie wird uns zeigen, dass der Winkel 6

zwischen v = D,2) und w = A,3) in Abbildung 1.7 genau 45° ist.

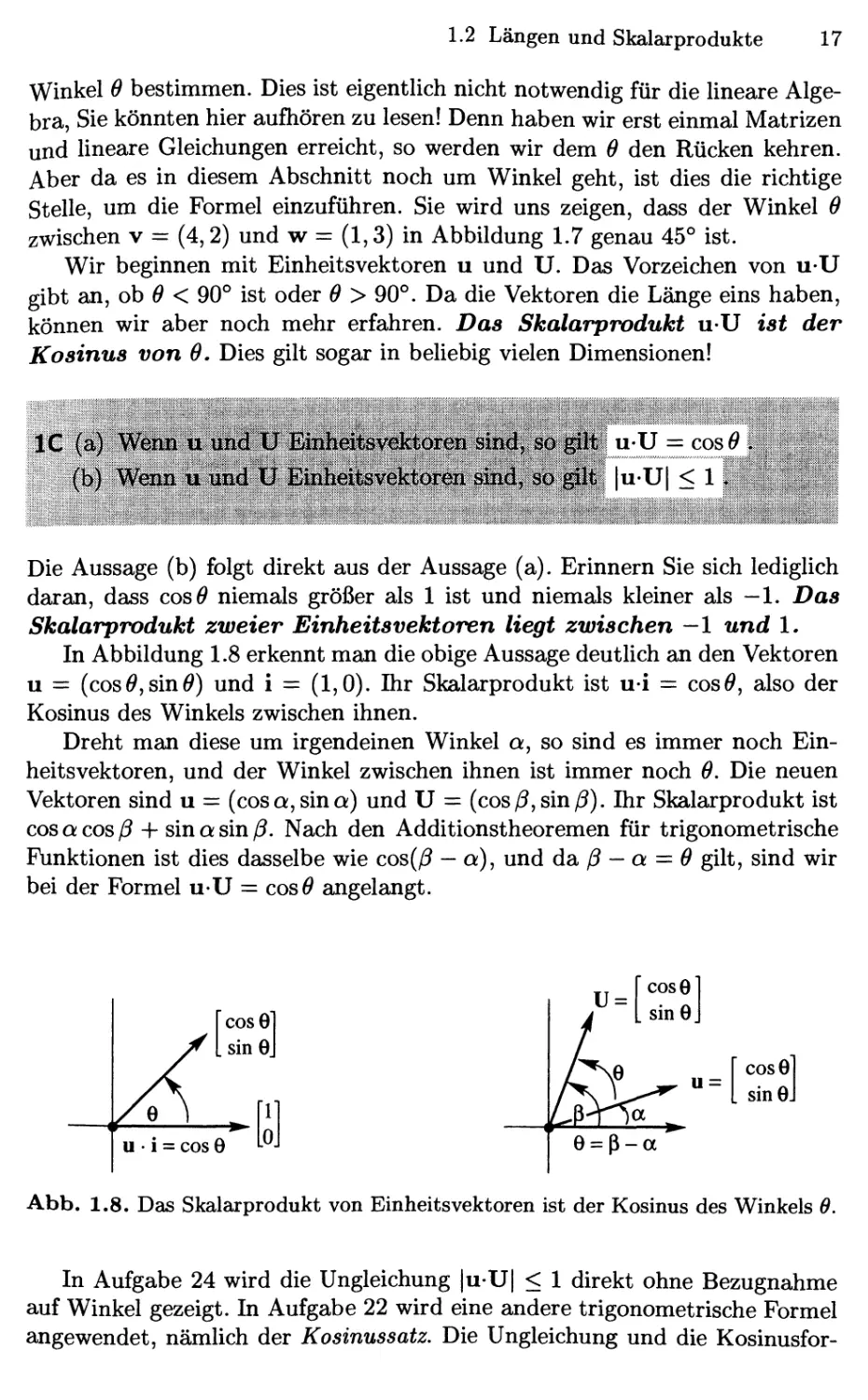

Wir beginnen mit Einheitsvektoren u und U. Das Vorzeichen von u-U

gibt an, ob ö < 90° ist oder 6 > 90°. Da die Vektoren die Länge eins haben,

können wir aber noch mehr erfahren. Das Skalarprodukt u-U ist der

Kosinus von 6, Dies gilt sogar in beliebig vielen Dimensionen!

IC (a) Wetiia mmli^^lJ BiBfa'dtsV^toreB'siBÄ^ u-U = cosö .

(b) Weciii 11' lind tF EinheiiÄvefeöireii s&wi, so;^li |u^'U| < 1. ^

Die Aussage (b) folgt direkt aus der Aussage (a). Erinnern Sie sich lediglich

daran, dass cosö niemals größer als 1 ist und niemals kleiner als —1. Das

Skalarprodukt zweier Einheitsvektoren liegt zwischen —1 und 1.

In Abbildung 1.8 erkennt man die obige Aussage deutlich an den Vektoren

u = (cosöjSinö) und i — A,0). Ihr Skalarprodukt ist u-i — cosO, also der

Kosinus des Winkels zwischen ihnen.

Dreht man diese um irgendeinen Winkel a, so sind es immer noch

Einheitsvektoren, und der Winkel zwischen ihnen ist immer noch 0. Die neuen

Vektoren sind u = (cos a, sin a) und U = (cos ^, sin ^). Ihr Skalarprodukt ist

cos a cos ^ + sin a sin ß. Nach den Additionstheoremen für trigonometrische

Funktionen ist dies dasselbe wie cos(^ — a), und da. ß — a = 0 gilt, sind wir

bei der Formel u-U = cosö angelangt.

u =

cosG

sinG.

e = ß-a

Abb. 1.8. Das Skalarprodukt von Einheitsvektoren ist der Kosinus des Winkels 6.

In Aufgabe 24 wird die Ungleichung |u-U| < 1 direkt ohne Bezugnahme

auf Winkel gezeigt. In Aufgabe 22 wird eine andere trigonometrische Formel

angewendet, nämlich der Kosinussatz, Die Ungleichung und die Kosinusfor-

18 1 Einführung in die Vektorrechnung

mel u-U = cos^ gelten für beUebige Dimensionen. Das Skalarprodukt ändert

sich nicht, wenn die Vektoren gedreht werden, weil 0 dabei unverändert bleibt.

Wie stellt sich die Situation dar, wenn v und w keine Einheitsvektoren

sind? Dann ist ihr Skalarprodukt im Allgemeinen nicht mehr cos^. Dividieren

wir sie aber durch ihre Längen, um Einheitsvektoren u = v/||v|| und U =

w/||w|| zu erhalten, so ist das Skalarprodukt dieser skalierten Vektoren wieder

cos^.

Unabhängig vom Winkel wird das Skalarprodukt von v/||v|| mit w/||w||

niemals größer als eins. Das ist die „Schwarz'sche Ungleichung" für Skalarpro-

dukte — oder richtiger die Cauchy-Schwarz-Buniakowsky'sche Ungleichung.

Sie wurde in Frankreich, in Deutschland und in Russland entdeckt (und

womöglich noch andernorts — es handelt sich hier um die wichtigste

Ungleichung der Mathematik). Mit dem zusätzlichen Faktor ||v|| ||w|| aus der

Umskalierung in Einheitsvektoren erhalten wir jetzt für cos^:

ID (a) Kostnusformel Siad v uiid w VekfcoreB tmglei^ nuH^ d^

= cos 6 .. j . ^ ^v ;^ ^ ■ V';"'' -;: - -- >''^#

^ . . i|v||||w|| '-;' ^ ■ ^.^J^^^. /'- '^-v;::';:':, V- ;-r<;. ^r' ::'":,[

(b) Sckwarz^sche Xlngleichiiiij^ Siiia v und/w pel|Bm]ge y^0yen^ Bö

:-,^U |v-w|<||v||||w||.^,^ >;,

Beispiel 1.2.5 Bestimmen Sie den Winkel zwischen v = [3] und w = [J] in

Abbildung 1.7b) .

Lösung Das Skalarprodukt ist v-w = 4 + 6 = 10. Die Länge von v ist

||v|| = \/20- Die Länge von w ist ||w|| = y/TÖ, Also ist der Kosinus des

Winkels

VW 10 1

cos^ = ,, ,,,,—TT = , ,— = —;=, und damit ist 0 = 45°.

||v||||w|| V2ÖVIÖ v^'

Der Winkel mit diesem Kosinus ist also gerade 45°. Er ist kleiner als 90°, weil

VW =: 10 positiv ist. Nach der Schwarz'schen Ungleichung ist ||v|| ||w|| =

V^ÖÖ größer als v-w = 10.

Beispiel 1.2.6 Das Skalarprodukt von v = (a, &) und w = {b,a) ist 2ab. Die

Schwarz'sche Ungleichung liefert 2ab < a^ + b^, zum Beispiel ist 2C)D) =

24 < 32 + 42 := 25.

Begründung Die Längen sind ||v|| = ||w|| = x/a^ + b^. Dann wird v-w = 2ab

niemals ||v|| ||w|| = a^ -\- b^ überschreiten, da die Differenz zwischen a^ + 6^

und 2ab niemals negativ werden kann:

a^ + ^2 _ 2ab ={a- bf > 0.

1.2 Längen und Skalaxprodukte 19

Diese Beziehung ist besser bekannt, wenn man x — c? und y — }? setzt, denn

dann heißt sie: Das „geometrische Mittel" ist nicht größer als das

„arithmetische Mittel", also der Mittelwert von x und y\

c? ^\? . x^y

ab < —-— wird zu ^yxy < —-—.

Die Berechnung von Skalarprodukten und Winkeln Die Zeit ist

reif für einen Augenblick der Wahrheit. Dem Skalarprodukt v-w begegnet

man normalerweise in der Form Zeile mal Spalte:

An Stelle von | ^

debt maB häufiger {1 2]

In FORTRAN benutzt man eine Schleife, um die Komponenten miteinander

zu multiplizieren und aufzuaddieren:

DO 10 I = 1,N

10 VMALW = VMALW + V(I) * W(I)

MATLAB arbeitet mit ganzen Vektoren, nicht mit ihren einzelnen

Komponenten. Sind V und w Spaltenvektoren, so ist v' eine Zeile wie oben:

skpr = v' * w

Die Länge von v ist in MATLAB schon als norni(v) bekannt. Wir könnten

sie aber auch selbst definieren als sqrt (v' * v), indem wir die ebenfalls

bekannte Wurzelfunktion benutzen. Kosinus und Winkel müssen wir uns selbst

berechnen:

cos = v' * w/(norni(v) * norni(w));

Winkel = acos(cos)

Wir haben dabei die Arcuscosinus-Funktion (acos) benutzt, um den Winkel

aus seinem Kosinus zu berechnen. Wir haben keine neue Funktion cos(v, w)

für den zukünftigen Gebrauch geschrieben. Dafür hätten wir eine M-Datei

erzeugen müssen, dessen Format in Kapitel 2 beschrieben werden wird.

(Speziell für dieses Buch sind einige M-Dateien geschrieben worden. Man findet

sie am Ende des Buches.) Die obigen Anweisungen führen dazu, dass die

Zahlen skpr und winkel ausgegeben werden. Der Kosinus wird wegen des

Semikolons am Ende der Zeile nicht ausgegeben.

Die wesentlichen Punkte

1. Das Skalarprodukt v-w wird durch Multiplizieren der Komponenten Vi mit

Wi und anschließendes Auf summieren berechnet.

2. Die Länge ||v|| ist die Quadratwurzel aus v-v.

3. Der Vektor v/||v|| ist ein Einheitsvektor, seine Länge ist eins.

20

1 Einführung in die Vektorrechnung

4. Es gilt v-w = 0, wenn v und w senkrecht zueinander stehen.

5. Der Kosinus von 6 (des Winkels zwischen v und w) überschreitet nie den

Wert 1:

cos 6 —

VW

und deshalb gilt |v-w| < ||v|| ||w||.

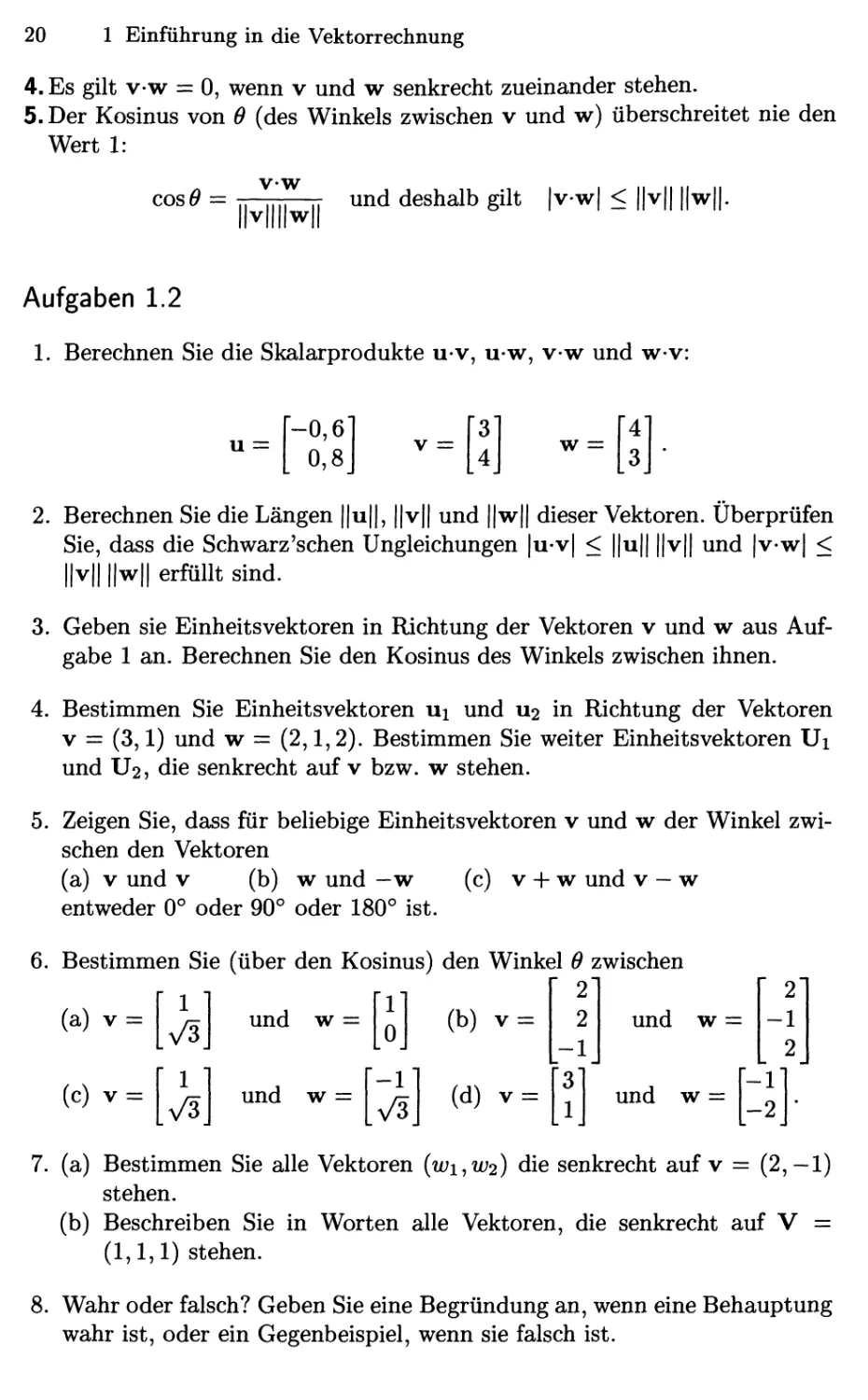

Aufgaben 1.2

1. Berechnen Sie die Skalarprodukte u-v, u-w, v-w und w-v:

u =

-0,6

0,8

v =

w

2. Berechnen Sie die Längen ||u||, ||v|| und ||w|| dieser Vektoren. Überprüfen

Sie, dass die Schwarz'schen Ungleichungen |u-v| < ||u|| ||v|| und |v-w| <

||v|| ||w|| erfüllt sind.

3. Geben sie Einheitsvektoren in Richtung der Vektoren v und w aus

Aufgabe 1 an. Berechnen Sie den Kosinus des Winkels zwischen ihnen.

4. Bestimmen Sie Einheitsvektoren ui und U2 in Richtung der Vektoren

V = C,1) und w = B,1,2). Bestimmen Sie weiter Einheitsvektoren Ui

und U2, die senkrecht auf v bzw. w stehen.

5. Zeigen Sie, dass für beliebige Einheitsvektoren v und w der Winkel

zwischen den Vektoren

(a) V und v (b) w und -w (c) v -f- w und v-w

entweder 0° oder 90° oder 180° ist.

6. Bestimmen Sie (über den Kosinus) den Winkel 6 zwischen

2

(b) V = ■

(a) v =

(c) v =

1

1

x/3

und w =

und w =

-1

(d) V

und w =

und w =

2

-1

2

1"

7. (a) Bestimmen Sie alle Vektoren {wi^W2) die senkrecht auf v = B,-1)

stehen,

(b) Beschreiben Sie in Worten alle Vektoren, die senkrecht auf V =

A,1,1) stehen.

8. Wahr oder falsch? Geben Sie eine Begründung an, wenn eine Behauptung

wahr ist, oder ein Gegenbeispiel, wenn sie falsch ist.

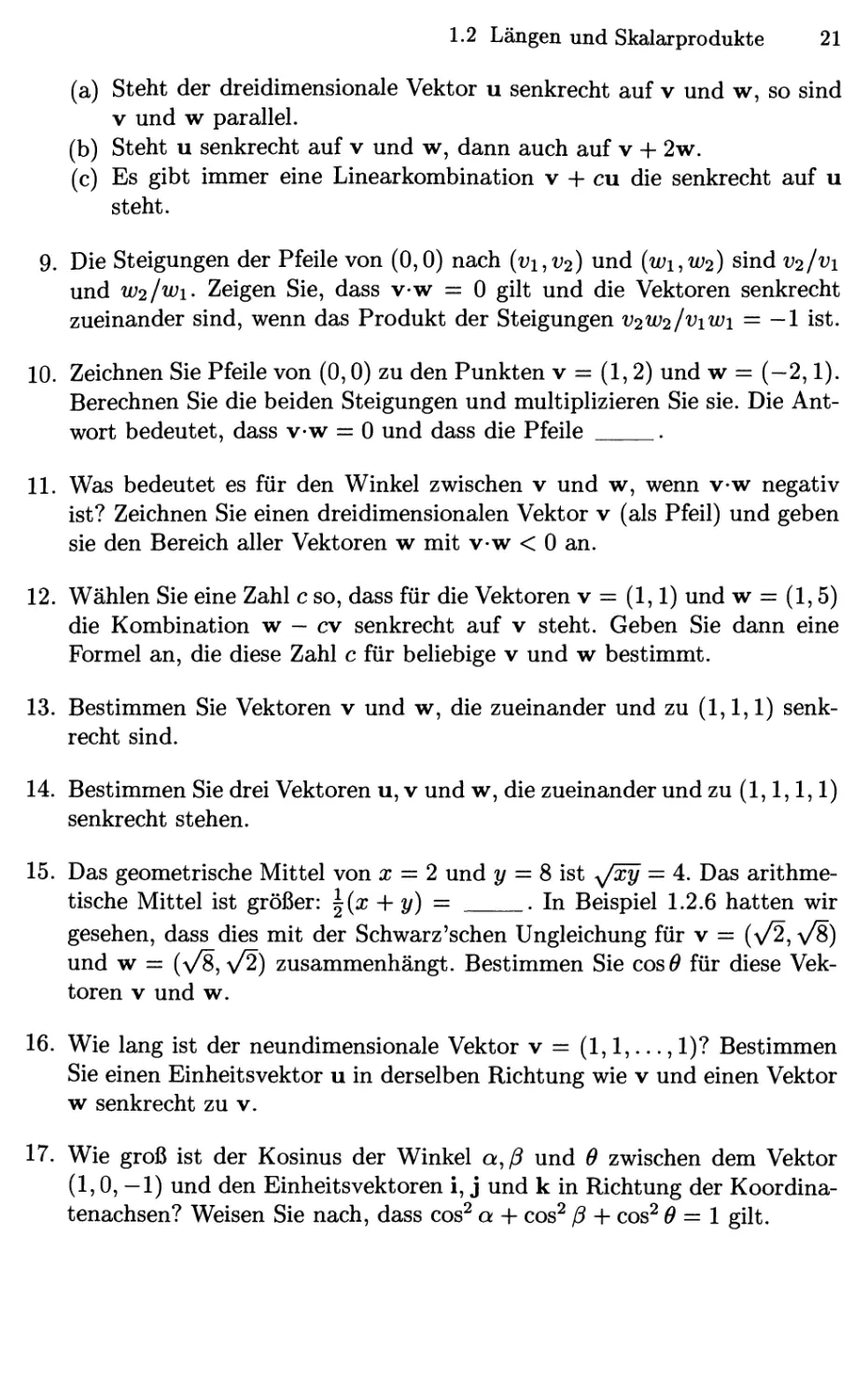

1.2 Längen und Skalarprodukte 21

(a) Steht der dreidimensionale Vektor u senkrecht auf v und w, so sind

V und w parallel.

(b) Steht u senkrecht auf v und w, dann auch auf v + 2w.

(c) Es gibt immer eine Linearkombination v + cu die senkrecht auf u

steht.

9. Die Steigungen der Pfeile von @,0) nach (i;i,i;2) und {wi,W2) sind i;2/^'i

und W2/W1. Zeigen Sie, dass v-w = 0 gilt und die Vektoren senkrecht

zueinander sind, wenn das Produkt der Steigungen V2W2/V1W1 = —1 ist.

10. Zeichnen Sie Pfeile von @,0) zu den Punkten v = A,2) und w = (-2,1).

Berechnen Sie die beiden Steigungen und multiplizieren Sie sie. Die

Antwort bedeutet, dass v-w = 0 und dass die Pfeile .

11. Was bedeutet es für den Winkel zwischen v und w, wenn v-w negativ

ist? Zeichnen Sie einen dreidimensionalen Vektor v (als Pfeil) und geben

sie den Bereich aller Vektoren w mit v-w < 0 an.

12. Wählen Sie eine Zahl c so, dass für die Vektoren v = A,1) und w = A,5)

die Kombination w — cv senkrecht auf v steht. Geben Sie dann eine

Formel an, die diese Zahl c für beliebige v und w bestimmt.

13. Bestimmen Sie Vektoren v und w, die zueinander und zu A,1,1)

senkrecht sind.

14. Bestimmen Sie drei Vektoren u, v und w, die zueinander und zu A,1,1,1)

senkrecht stehen.

15. Das geometrische Mittel von x = 2 und ?/ = 8 ist ^/xy — 4. Das

arithmetische Mittel ist größer: \{x -\-y) = . In Beispiel 1.2.6 hatten wir

gesehen, dass dies mit der Schwarz'sehen Ungleichung für v = (\/2, VS)

und w = (v^, \/2) zusammenhängt. Bestimmen Sie cosö für diese

Vektoren V und w.

16. Wie lang ist der neundimensionale Vektor v = A,1,...,1)? Bestimmen

Sie einen Einheitsvektor u in derselben Richtung wie v und einen Vektor

w senkrecht zu v.

17. Wie groß ist der Kosinus der Winkel a^ß und 9 zwischen dem Vektor

A,0, —1) und den Einheitsvektoren i, j und k in Richtung der

Koordinatenachsen? Weisen Sie nach, dass cos^ a -f- cos^ ß -h cos^ 6 =\ gilt.

22 1 Einführung in die Vektorrechnung

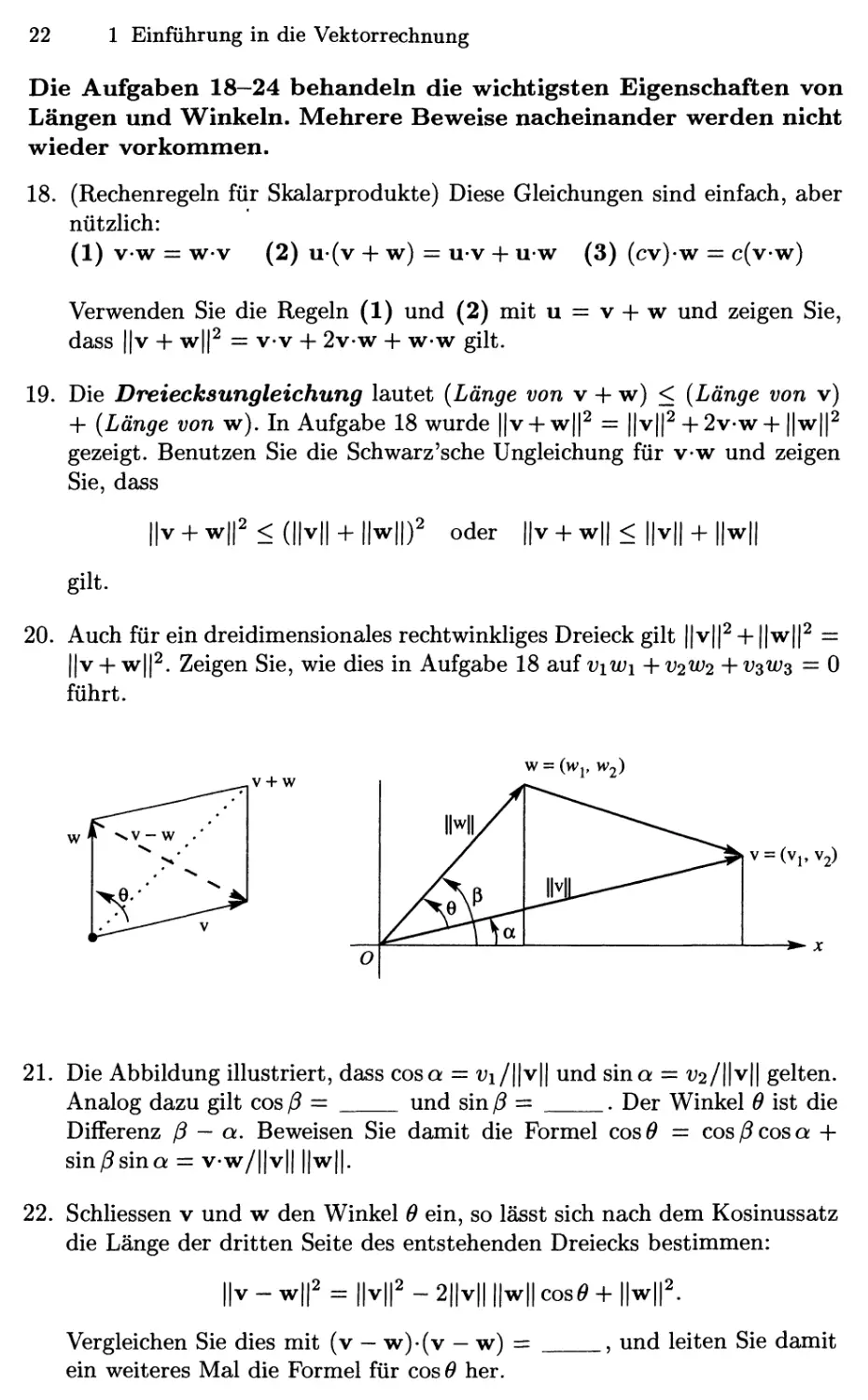

Die Aufgaben 18—24 behandeln die wichtigsten Eigenschaften von

Längen und Winkeln. Mehrere Beweise nacheinander werden nicht

wieder vorkommen.

18. (Rechenregeln für Skalarprodukte) Diese Gleichungen sind einfach, aber

nützlich:

A) v-w = w-v B) u-(v + w) = u-v + u-w C) (cv)-w = c(v-w)

Verwenden Sie die Regeln A) und B) mit u = v + w und zeigen Sie,

dass ||v + w|p = v-v + 2v-w + w-w gilt.

19. Die Dreiecksungleichung lautet {Länge von v + w) < {Länge von v)

+ {Länge von w). In Aufgabe 18 wurde ||v + w|p = ||v|p+ 2v-w +||w|p

gezeigt. Benutzen Sie die Schwarz'sehe Ungleichung für v-w und zeigen

Sie, dass

||v + w||2<(||v|| + ||w||J oder ||v + w|| < ||v|| + ||w||

gilt.

20. Auch für ein dreidimensionales rechtwinkliges Dreieck gilt ||v|p + ||w|p =

||v + w|p. Zeigen Sie, wie dies in Aufgabe 18 auf viWi + V2W2 + v^ws = 0

führt.

W = (Wp W2)

V = (Vi,V2)

21. Die Abbildung illustriert, dass cos a = i;i/||v|| und sina = i;2/||v|| gelten.

Analog dazu gilt cos ß = und sin ß = . Der Winkel 0 ist die

Differenz ß — a. Beweisen Sie damit die Formel cosö = cos/? cos a +

sin/?sina = v-w/||v|| ||w||.

22. Schliessen v und w den Winkel 6 ein, so lässt sich nach dem Kosinussatz

die Länge der dritten Seite des entstehenden Dreiecks bestimmen:

||v-w|p = ||v||2-2||v|||H|cosö+||w||2.

Vergleichen Sie dies mit (v — w)-(v — w) =

ein weiteres Mal die Formel für cos 0 her.

., und leiten Sie damit

1.2 Längen und Skalarprodukte 23

23. Die Schwarz'sche Ungleichung lässt sich auch algebraisch statt

trigonometrisch beweisen:

(a) Multiplizieren Sie beide Seiten der Ungleichung {viWi + V2W2)^ <

{vi + V2){wl -h W2) aus.

(b) Zeigen Sie, dass die Differenz beider Seiten gleich {viW2 - V2Wi)^ ist.

Da dies nicht negativ sein kann, muss die Ungleichung immer erfüllt

sein.

24. Ein einzeiliger Beweis der Schwarz'schen Ungleichung |u • U| < 1:

Sind (wi,W2) und {Ui,U2) Einheitsvektoren, wende den Schritt aus

Beispiel 1.2.6 an:

lu.u|<Kr.| + H|f/.l<^ + ^ = i^ = i.

Setzen Sie (^1,^2) = @,6, 0,8) und {Ui,U2) = @,8, 0,6) in dieser Zeile

und bestimmen Sie 0.

25. Warum ist | cosö| überhaupt niemals größer als 1?

26. Wählen Sie beliebige Zahlen x,y, und z mit x -{- y -{- z = 0.

Bestimmen Sie den Winkel zwischen dem Vektor v = {x,y,z) und dem Vektor

w = {z,x,y). Noch eine Herausforderung: Erklären Sie, warum immer

vw/||v||||w|| = -i gilt.

27. Es sei ||v|| = 5 und ||w|| = 3. Bestimmen Sie die kleinsten und die größten

möglichen Werte von ||v — w|| und v • w.

2 Das Lösen linearer Gleichungen

2.1 Vektoren und lineare Gleichungen

Die zentrale Problemstellung der linearen Algebra besteht in der Lösung eines

Systems von Gleichungen. Diese Gleichungen sind linear, was bedeutet, dass

die Unbekannten nur mit Zahlen multipliziert werden — es taucht niemals

ein Produkt x mal y auf. Unser erstes Beispiel für ein lineares System ist

sicherlich nicht groß. Es enthält zwei Gleichungen mit zwei Unbekannten.

Doch wir werden sehen, wie weit uns das führt:

X -2y = 1

Sx + 2y = 11

B.1)

Eine Möglichkeit, diese Gleichungen zu lösen, besteht darin, Zeile für Zeile

vorzugehen. Die erste Zeile ist x — 2^/ = 1. Diese Gleichung entspricht einer

Geraden in der x-y-Ebene. Der Punkt x = 1, y = 0 Hegt auf dieser Geraden,

weil er die Gleichung löst. Der Punkt x = 3, y = 1 liegt ebenso auf der

Geraden, weil 3 — 2 == 1 ist. Wählen wir x = 101, so erhalten wir y = 50. Die

Steigung dieser speziellen Geraden ist |. Steigungen kommen aber doch in

der Analysis vor, hier geht es jedoch um lineare Algebra!

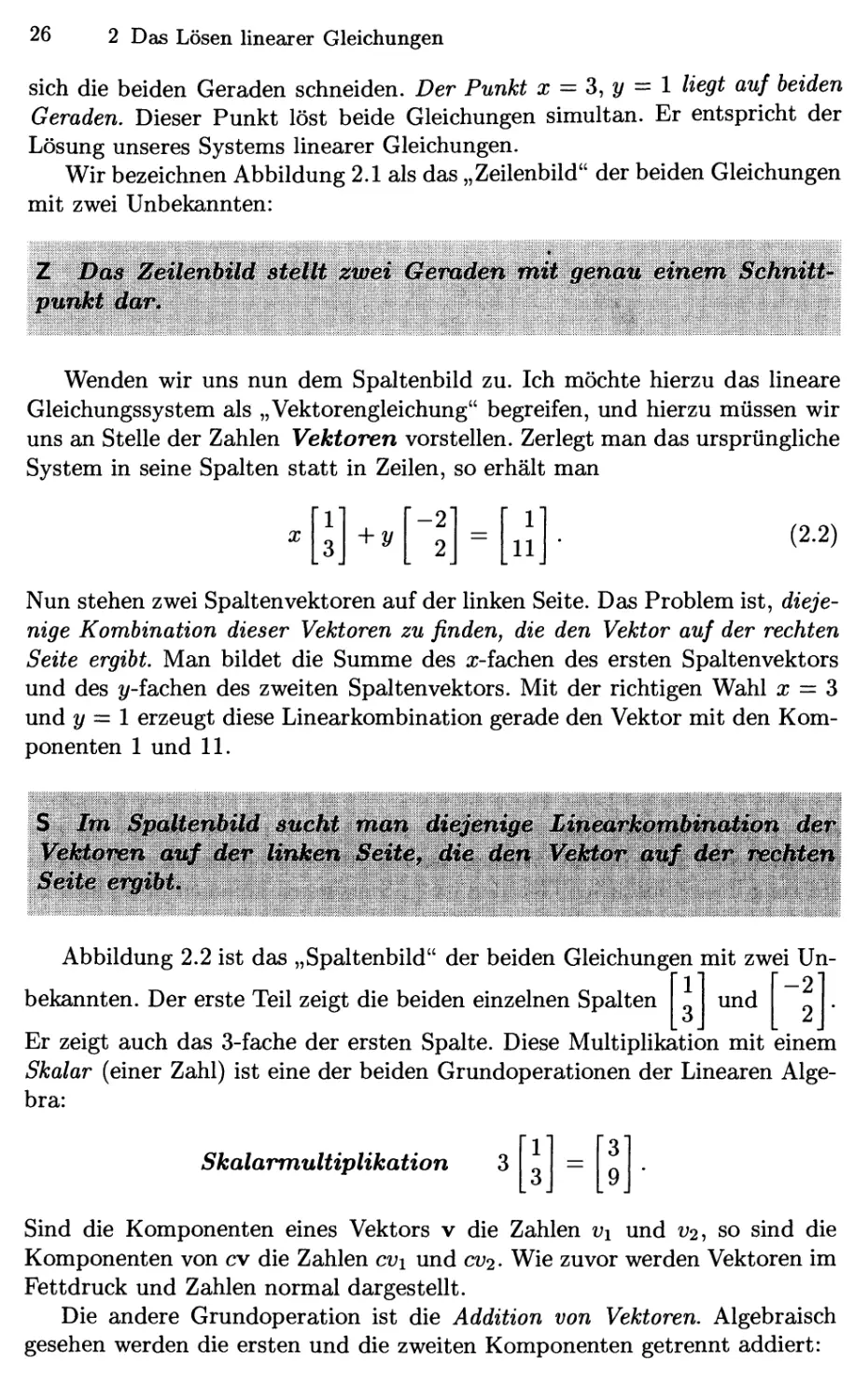

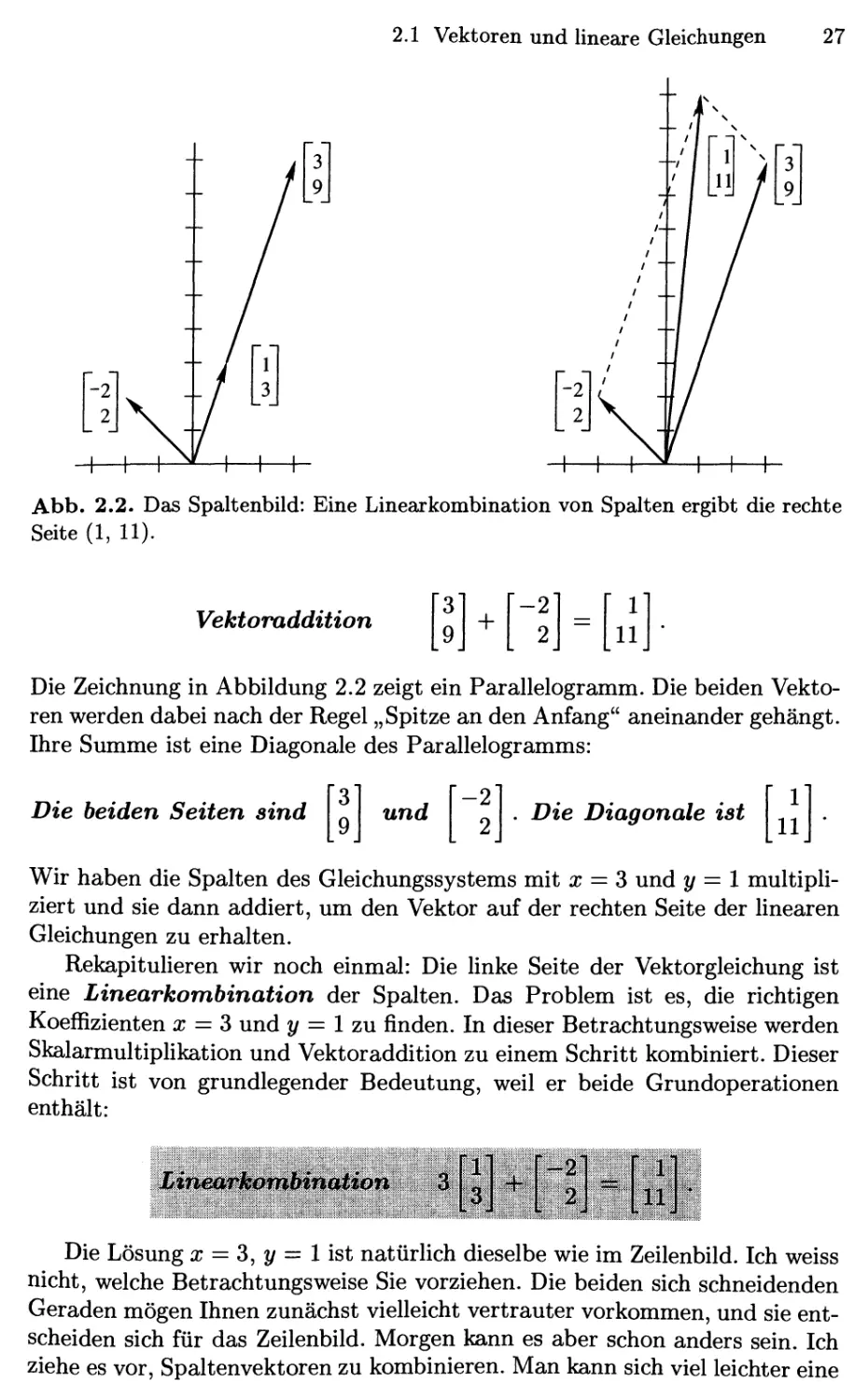

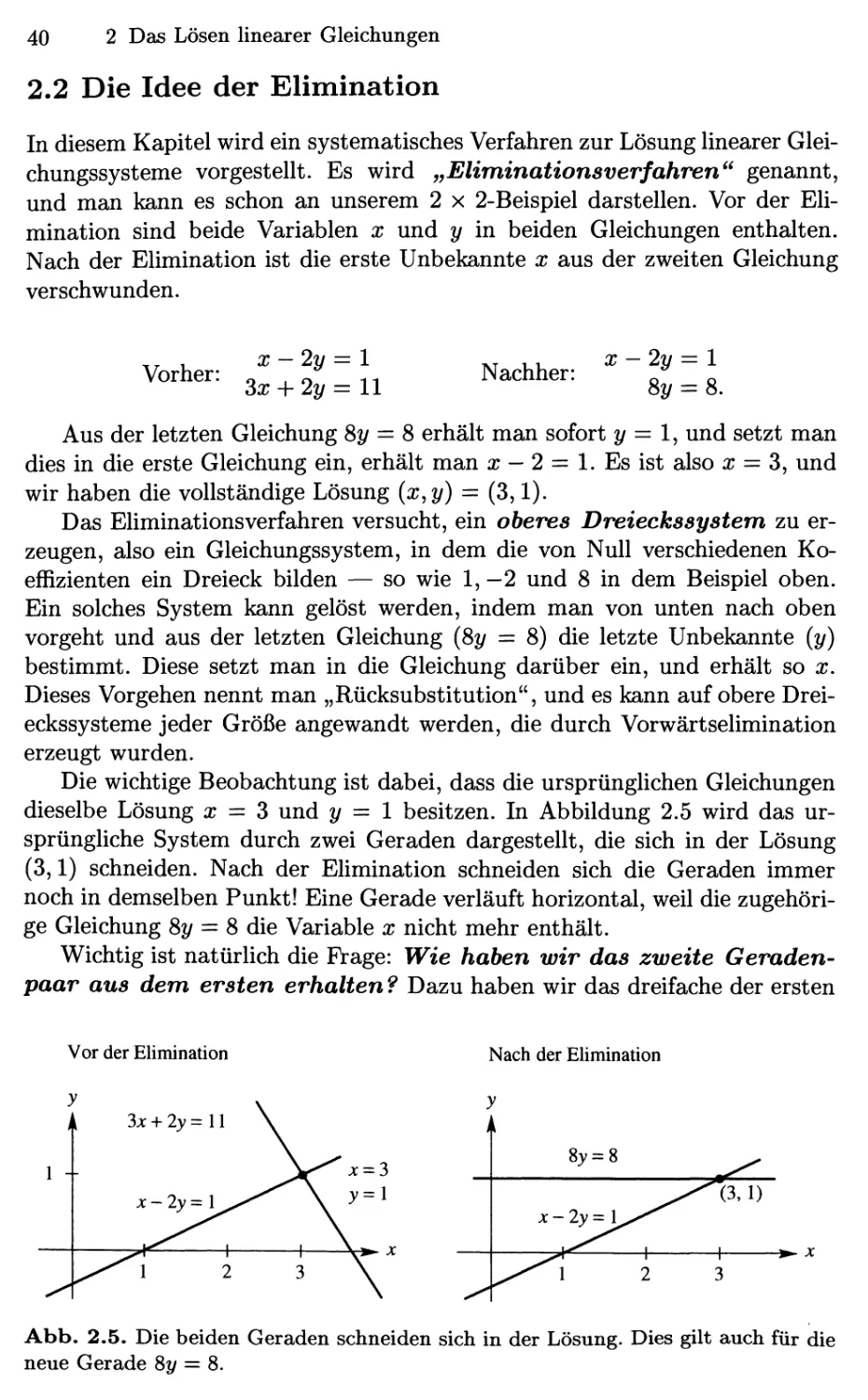

Abb. 2.1. Das Zeilenbild: Der Punkt, an dem sich die Geraden schneiden, stellt

die Lösung dar.

In Abbildung 2.1 ist die Gerade x-2y = 1 dargestellt. Die andere Gerade

in der Abbildung gehört zur Gleichung 3x -\-2y = 11. Man sieht sofort, dass

26

2 Das Lösen linearer Gleichungen

sich die beiden Geraden schneiden. Der Punkt x = S, y = l hegt auf beiden

Geraden. Dieser Punkt löst beide Gleichungen simultan. Er entspricht der

Lösung unseres Systems linearer Gleichungen.

Wir bezeichnen Abbildung 2.1 als das „Zeilenbild" der beiden Gleichungen

mit zwei Unbekannten:

Z Das Zeiienbild Btellt zwei Geraden mit genau einem Schnitt^

punJst dar^

Wenden wir uns nun dem Spaltenbild zu. Ich möchte hierzu das lineare

Gleichungssystem als „Vektorengleichung" begreifen, und hierzu müssen wir

uns an Stelle der Zahlen Vektoren vorstellen. Zerlegt man das ursprüngliche

System in seine Spalten statt in Zeilen, so erhält man

1

:3

+ y

-2

2

=

1

llj

B.2)

Nun stehen zwei Spaltenvektoren auf der linken Seite. Das Problem ist,

diejenige Kombination dieser Vektoren zu finden, die den Vektor auf der rechten

Seite ergibt. Man bildet die Summe des x-fachen des ersten Spaltenvektors

und des ^/-fachen des zweiten Spaltenvektors. Mit der richtigen Wahl x = S

und y = 1 erzeugt diese Linearkombination gerade den Vektor mit den

Komponenten 1 und 11.

S Im SpalfenbUd mcht man diejßn^e LifhbokvfipmlJ^

VfUomn mf dßf linkten Seiie^ 4te den V^Mor^^ ^^a^k r^phieti;

Seite ergibt^;.; ., ; ^ ^=;. ' ^ ' ^^ '/';-': ,.;.-''}/\; -:;/^ c~./^■''x:'i /'> \^-''

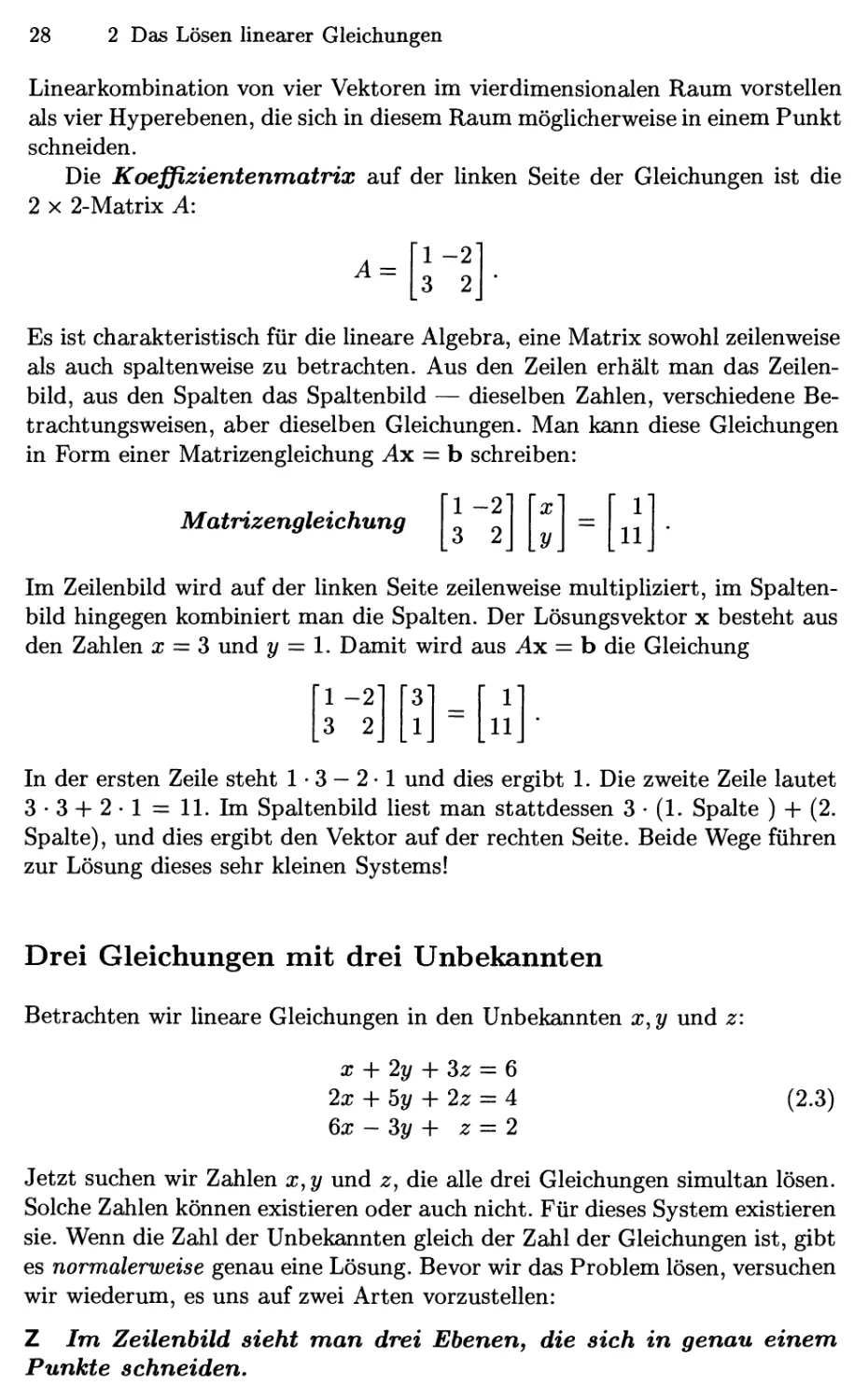

Abbildung 2.2 ist das „Spaltenbild" der beiden Gleichungen mit zwei

Unbekannten. Der erste Teil zeigt die beiden einzelnen Spalten

und

-2

2

Er zeigt auch das 3-fache der ersten Spalte. Diese Multiplikation mit einem

Skalar (einer Zahl) ist eine der beiden Grundoperationen der Linearen

Algebra:

Skalarmultiplikation

Sind die Komponenten eines Vektors v die Zahlen vi und V2, so sind die

Komponenten von cv die Zahlen cvi und cv2' Wie zuvor werden Vektoren im

Fettdruck und Zahlen normal dargestellt.

Die andere Grundoperation ist die Addition von Vektoren. Algebraisch

gesehen werden die ersten und die zweiten Komponenten getrennt addiert:

2.1 Vektoren und lineare Gleichungen

27

Abb. 2.2. Das Spaltenbild: Eine Lineaxkombination von Spalten ergibt die rechte

Seite A, 11).

Vektoraddition

Die Zeichnung in Abbildung 2.2 zeigt ein Parallelogramm. Die beiden

Vektoren werden dabei nach der Regel „Spitze an den Anfang" aneinander gehängt.

Ihre Summe ist eine Diagonale des Parallelogramms:

3'

9

+

■-2'

2

=

r

11

Die beiden Seiten sind

und

-2

2

Die Diagonale ist

Wir haben die Spalten des Gleichungssystems mit x = S und y = 1

multipliziert und sie dann addiert, um den Vektor auf der rechten Seite der linearen

Gleichungen zu erhalten.

Rekapitulieren wir noch einmal: Die Hnke Seite der Vektorgleichung ist

eine Linearkomhination der Spalten. Das Problem ist es, die richtigen

Koeffizienten x = 3 und y = 1 zu finden. In dieser Betrachtungsweise werden

SkalarmultipHkation und Vektoraddition zu einem Schritt kombiniert. Dieser

Schritt ist von grundlegender Bedeutung, weil er beide Grundoperationen

enthält:

\1.

'^J'

«i,.;

"•:i;l

Mnm^rkomMntjkiim 3

Die Lösung x = 3, y = 1 ist natürlich dieselbe wie im Zeilenbild. Ich weiss

nicht, welche Betrachtungsweise Sie vorziehen. Die beiden sich schneidenden

Geraden mögen Ihnen zunächst vielleicht vertrauter vorkommen, und sie

entscheiden sich für das Zeilenbild. Morgen kann es aber schon anders sein. Ich

ziehe es vor, Spaltenvektoren zu kombinieren. Man kann sich viel leichter eine

28

2 Das Lösen linearer Gleichungen

Linearkombination von vier Vektoren im vierdimensionalen Raum vorstellen

als vier Hyperebenen, die sich in diesem Raum möglicherweise in einem Punkt

schneiden.

Die Koeffizientenmatrix auf der linken Seite der Gleichungen ist die

2 X 2-Matrix A:

A =

1 -2

3 2

Es ist charakteristisch für die lineare Algebra, eine Matrix sowohl zeilenweise

als auch spaltenweise zu betrachten. Aus den Zeilen erhält man das

Zeilenbild, aus den Spalten das Spaltenbild — dieselben Zahlen, verschiedene

Betrachtungsweisen, aber dieselben Gleichungen. Man kann diese Gleichungen

in Form einer Matrizengleichung Ax = b schreiben:

Matrizengleichung

Im Zeilenbild wird auf der linken Seite zeilenweise multipliziert, im

Spaltenbild hingegen kombiniert man die Spalten. Der Lösungsvektor x besteht aus

den Zahlen x = S und y = l. Damit wird aus Ax = b die Gleichung

-2"

3 2

X

y.

=

r

11

'1 -2'

3 2

"

1

=

r

11

In der ersten Zeile steht 1 • 3 — 2 • 1 und dies ergibt 1. Die zweite Zeile lautet

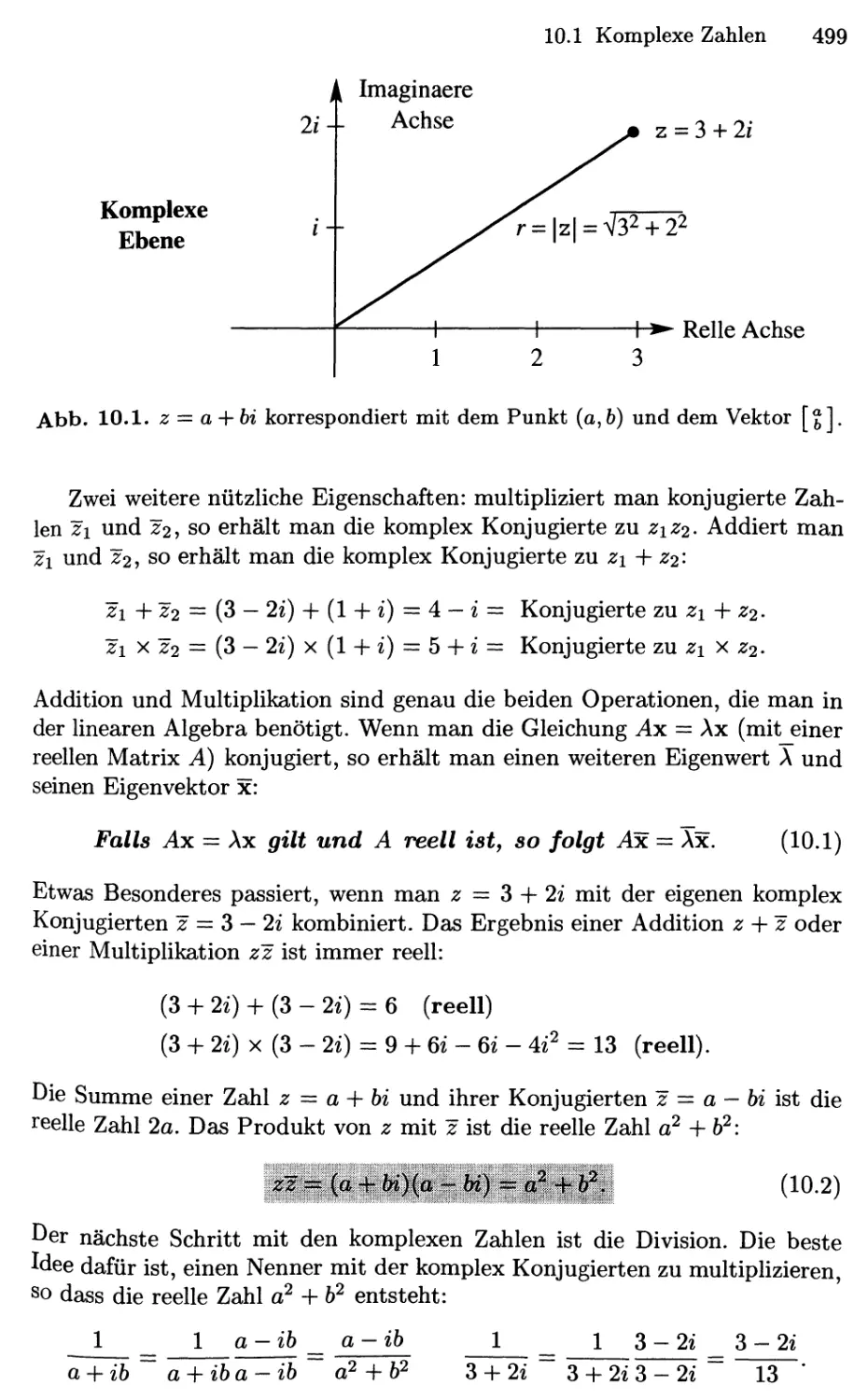

3-3 + 2-l = ll. Im Spaltenbild liest man stattdessen 3 • A. Spalte ) -f- B.

Spalte), und dies ergibt den Vektor auf der rechten Seite. Beide Wege führen

zur Lösung dieses sehr kleinen Systems!

Drei Gleichungen mit drei Unbekannten

Betrachten wir lineare Gleichungen in den Unbekannten x,y und z:

X -\-2y -\-Sz = 6

2x + by -\-2z = 4

dx - Sy + z = 2

B.3)

Jetzt suchen wir Zahlen x,y und z, die alle drei Gleichungen simultan lösen.

Solche Zahlen können existieren oder auch nicht. Für dieses System existieren

sie. Wenn die Zahl der Unbekannten gleich der Zahl der Gleichungen ist, gibt

es normalerweise genau eine Lösung. Bevor wir das Problem lösen, versuchen

wir wiederum, es uns auf zwei Arten vorzustellen:

Z Im Zeilenbild sieht man drei Ebenen, die sich in genau einem.

Punkte schneiden.

2.1 Vektoren und lineare Gleichungen

29

S Im Spaltenbild werden drei Spalten kombiniert, um, die vierte

Spalte zu erzeugen.

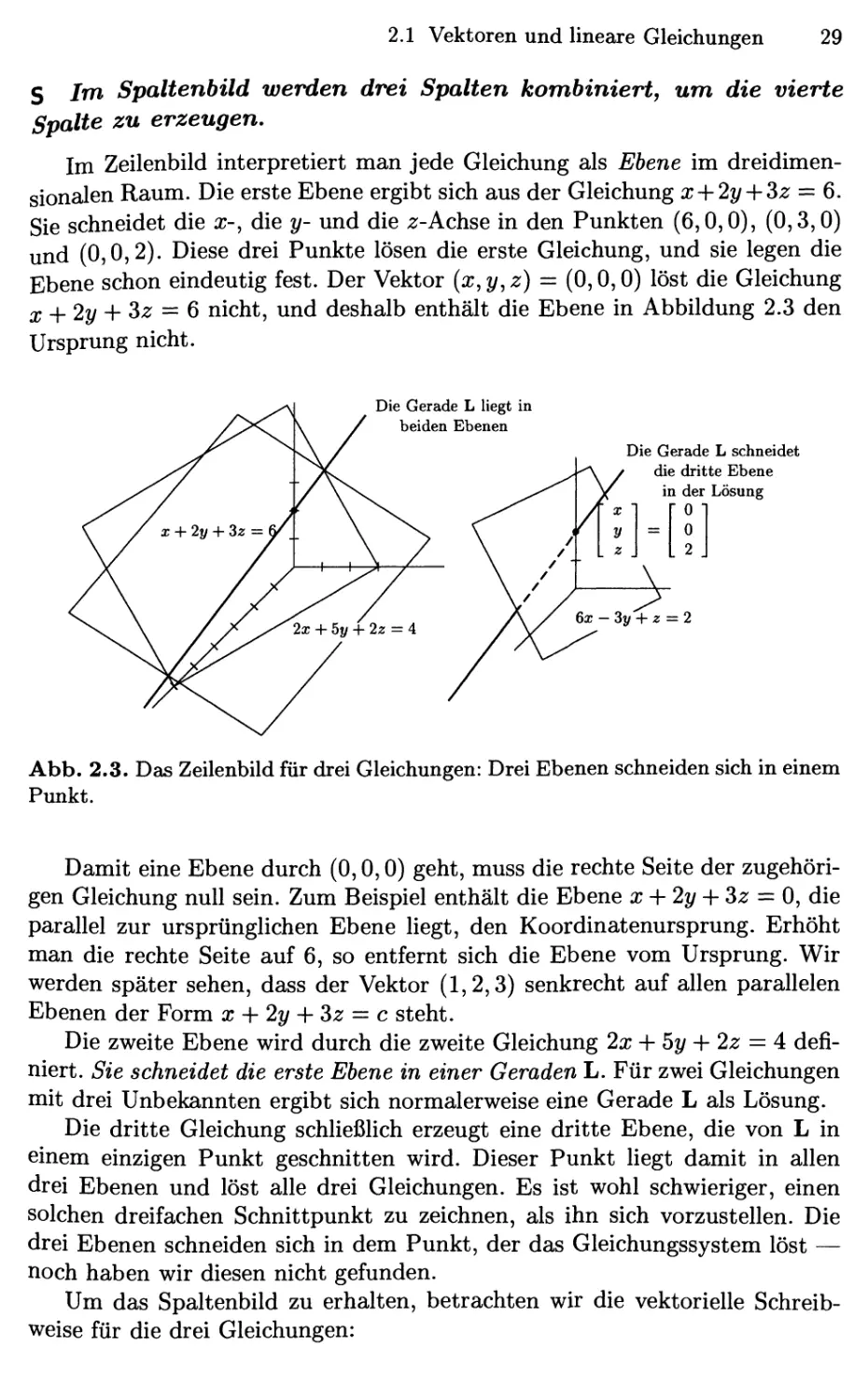

Im Zeilenbild interpretiert man jede Gleichung als Ebene im

dreidimensionalen Raum. Die erste Ebene ergibt sich aus der Gleichung x-\-2y-\-^z =^ Qt.

Sie schneidet die x-, die y- und die 2:-Achse in den Punkten F,0,0), @,3,0)

und @,0,2). Diese drei Punkte lösen die erste Gleichung, und sie legen die

Ebene schon eindeutig fest. Der Vektor {x,y,z) = @,0,0) löst die Gleichung

j, ^2y -\-Sz = 6 nicht, und deshalb enthält die Ebene in Abbildung 2.3 den

Ursprung nicht.

Die Gerade L liegt in

beiden Ebenen

Die Gerade L schneidet

die dritte Ebene

in der Lösung

0

= I 0

6x-3y + z = 2

Abb. 2.3. Das Zeilenbild für drei Gleichungen: Drei Ebenen schneiden sich in einem

Punkt.

Damit eine Ebene durch @,0,0) geht, muss die rechte Seite der

zugehörigen Gleichung null sein. Zum Beispiel enthält die Ebene x-{-2y-\-Sz = 0, die

parallel zur ursprünglichen Ebene liegt, den Koordinatenursprung. Erhöht

man die rechte Seite auf 6, so entfernt sich die Ebene vom Ursprung. Wir

werden später sehen, dass der Vektor A,2,3) senkrecht auf allen parallelen

Ebenen der Form x -\- 2y -\- Sz = c steht.

Die zweite Ebene wird durch die zweite Gleichung 2x -\- 5y + 2z = 4

definiert. Sie schneidet die erste Ebene in einer Geraden L. Für zwei Gleichungen

mit drei Unbekannten ergibt sich normalerweise eine Gerade L als Lösung.

Die dritte Gleichung schUeßHch erzeugt eine dritte Ebene, die von L in

einem einzigen Punkt geschnitten wird. Dieser Punkt Hegt damit in allen

drei Ebenen und löst alle drei Gleichungen. Es ist wohl schwieriger, einen

solchen dreifachen Schnittpunkt zu zeichnen, als ihn sich vorzustellen. Die

drei Ebenen schneiden sich in dem Punkt, der das Gleichungssystem löst —

noch haben wir diesen nicht gefunden.

Um das Spaltenbild zu erhalten, betrachten wir die vektorielle

Schreibweise für die drei Gleichungen:

30

2 Das Lösen linearer Gleichungen

1

2

6

+ y

2

5

-3

-\-z

3

2

1

=

6

4

2

B.4)

Die Unbekannten x,^/, und z sind die Koeffizienten in dieser Linearkombina-

tion. Wir suchen die richtigen Vielfachen der drei Spaltenvektoren, so dass

deren Summe b = F,4,2) ergibt.

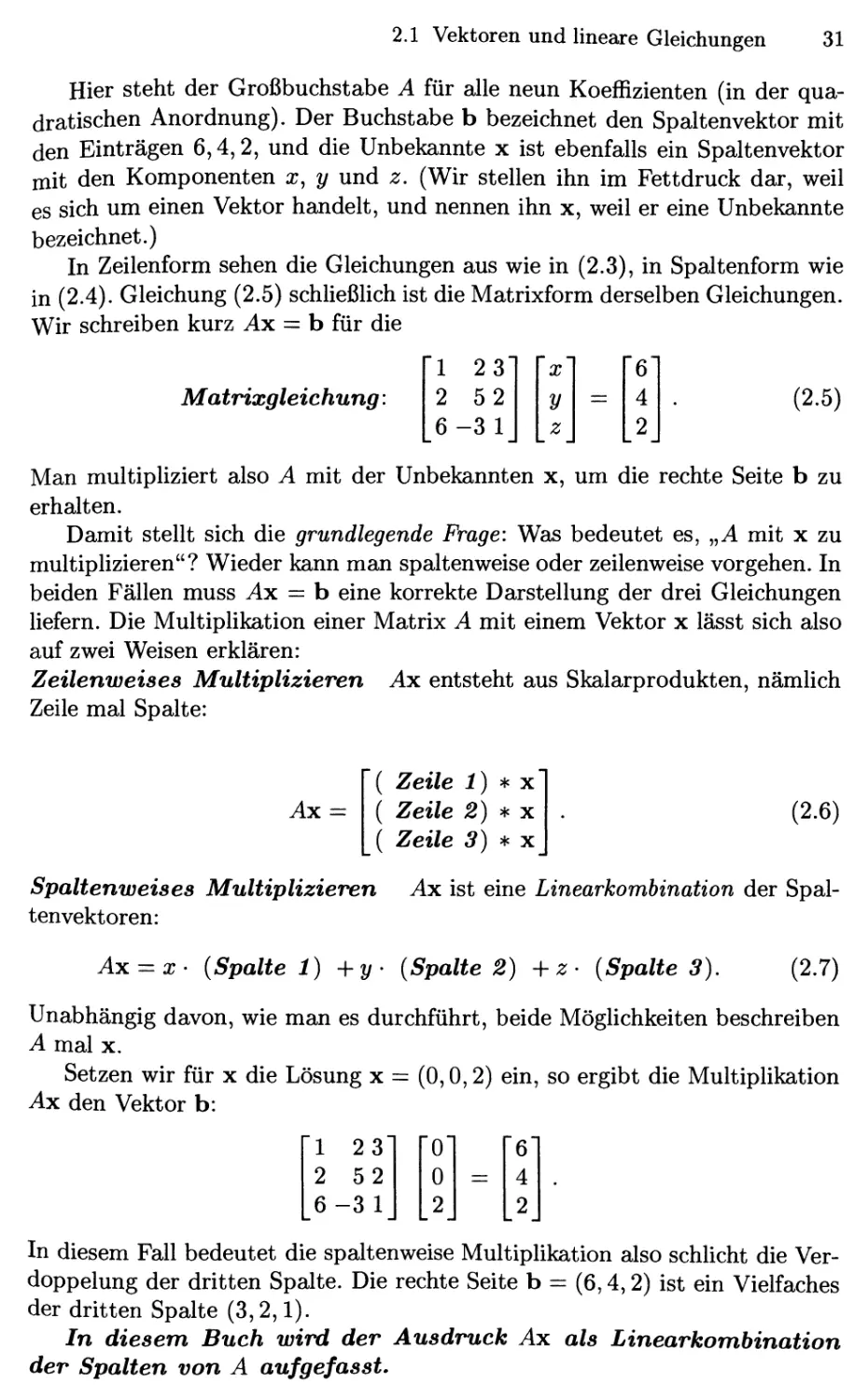

Abb. 2.4. Das Spaltenbild: Die Lösung ist (x,y,z)

doppelte der dritten Spalte ist.

@,0,2), da b gerade das

Abbildung 2.4 zeigt das Spaltenbild. Linearkombinationen dieser Spalten

können alle möglichen rechten Seiten erzeugen, und die Kombination, die b =

F,4,2) ergibt, ist einfach 2-C. Spalte). Wir benötigen also die Koeffizienten

X = 0, y = 0, und z = 2.

Dies ist gleichzeitig der Schnittpunkt der drei Ebenen aus dem Zeilenbild.

Es ist die Lösung des linearen Gleichungssystems:

1

2

6

+ 0

2

5

-3

+ 2

3

2

1

=

6

4

2

Die Matrixform der Gleichungen

Im Zeilenbild betrachten wir drei Zeilen, im Spaltenbild drei Spalten (und

zusätzlich noch die rechte Seite). Die drei Zeilen oder Spalten enthalten

zusammen neun ZahlÄi. Diese neun Zahlen erzeugen eine 3 x 3-Matrix. Diese

„KoefBzientematrix" enthält die Zeilen bzw. Spalten, die wir bislang getrennt

betrachtet haben:

Die Koeffizientenmatrix ist A =

1 23

2 52

6-3 1

2.1 Vektoren und lineare Gleichungen 31

Hier steht der Großbuchstabe A für alle neun Koeffizienten (in der

quadratischen Anordnung). Der Buchstabe b bezeichnet den Spaltenvektor mit

den Einträgen 6,4,2, und die Unbekannte x ist ebenfalls ein Spaltenvektor

mit den Komponenten x, y und z. (Wir stellen ihn im Fettdruck dar, weil

es sich um einen Vektor handelt, und nennen ihn x, weil er eine Unbekannte

bezeichnet.)

In Zeilenform sehen die Gleichungen aus wie in B.3), in Spaltenform wie

in B.4). Gleichung B.5) schließlich ist die Matrixform derselben Gleichungen.

Wir schreiben kurz Ax = b für die

Matrixgleichung:

^1 23"

2 52

6-3 1

X

y

z

=

'61

4

2

B.5)

Man multipliziert also A mit der Unbekannten x, um die rechte Seite b zu

erhalten.

Damit stellt sich die grundlegende Frage: Was bedeutet es, „A mit x zu

multiplizieren"? Wieder kann man spaltenweise oder zeilenweise vorgehen. In

beiden Fällen muss ^x = b eine korrekte Darstellung der drei Gleichungen

liefern. Die Multiplikation einer Matrix A mit einem Vektor x lässt sich also

auf zwei Weisen erklären:

Zeilenweises Multiplizieren Ax entsteht aus Skalarprodukten, nämlich

Zeile mal Spalte:

Ax =

( Zeile i) * X

( Zeile 2) * X

( Zeile 3) * X

B.6)

Spaltenweises Multiplizieren Ax ist eine Linearkombination der

Spaltenvektoren:

Ax:=X' {Spalte 1) -\-y' [Spalte 2) -\-z - {Spalte 3).

B.7)

Unabhängig davon, wie man es durchführt, beide Möglichkeiten beschreiben

A mal X.

Setzen wir für x die Lösung x — @,0,2) ein, so ergibt die Multiplikation

Ax den Vektor b:

23"

2 52

[6-3 1

"

0

2

-

1

4

2

In diesem Fall bedeutet die spaltenweise Multiplikation also schlicht die

Verdoppelung der dritten Spalte. Die rechte Seite b — F,4,2) ist ein Vielfaches

der dritten Spalte C,2,1).

In diesem Buch wird der Ausdruck Ax als Linearkombination

der Spalten von A aufgefasst.

32

2 Das Lösen linearer Gleichungen

10 0"

100

100

"

5

6

=

■

4

4

/x =

00'

010

001

5

6

=

5

6

Man kann zwar auch zeilenweise rechnen, sollte aber die spaltenweise

Multiplikation im Hinterkopf behalten.

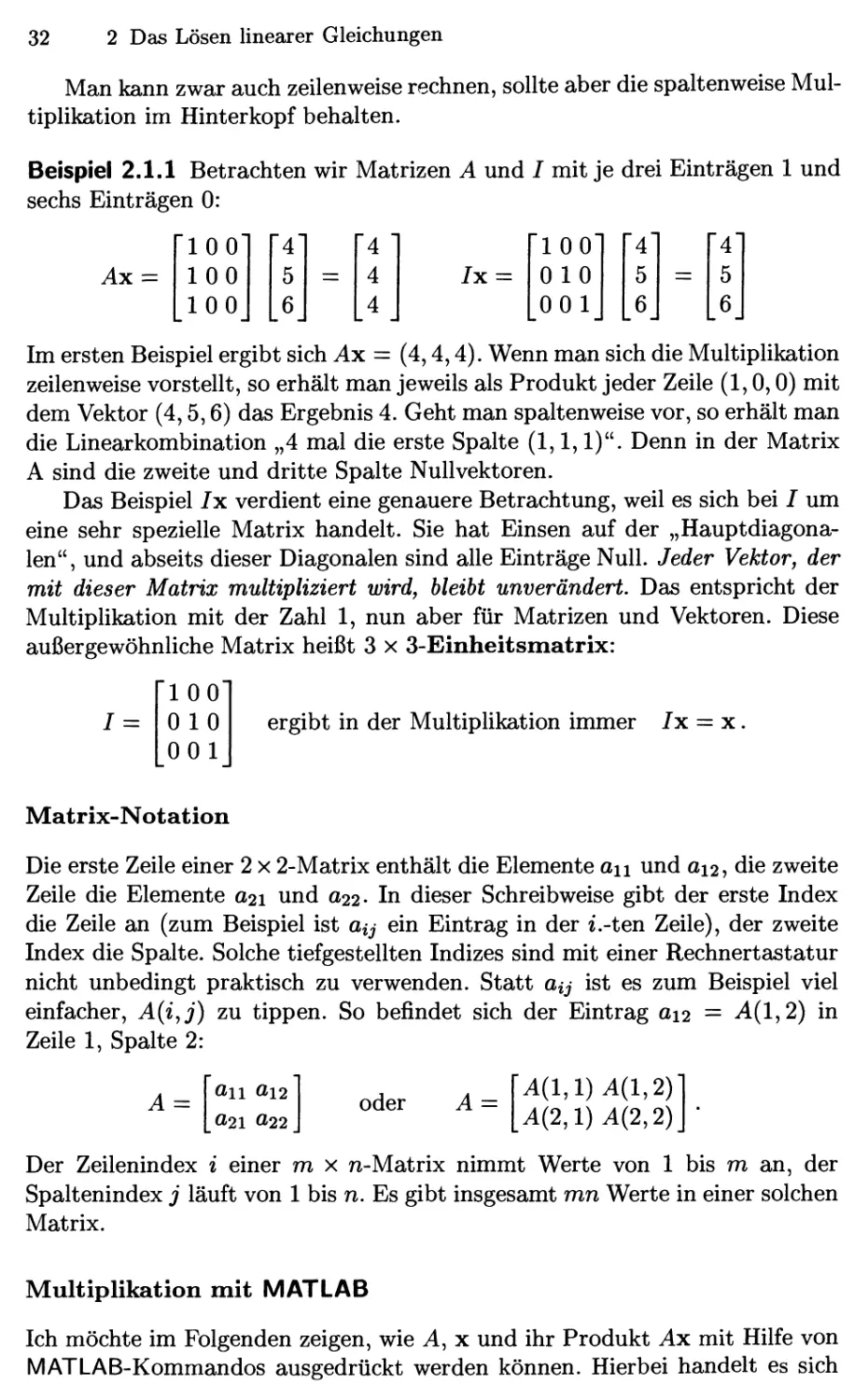

Beispiel 2.1.1 Betrachten wir Matrizen A und / mit je drei Einträgen 1 und

sechs Einträgen 0:

Ax =

Im ersten Beispiel ergibt sich Ax = D,4,4). Wenn man sich die Multiplikation

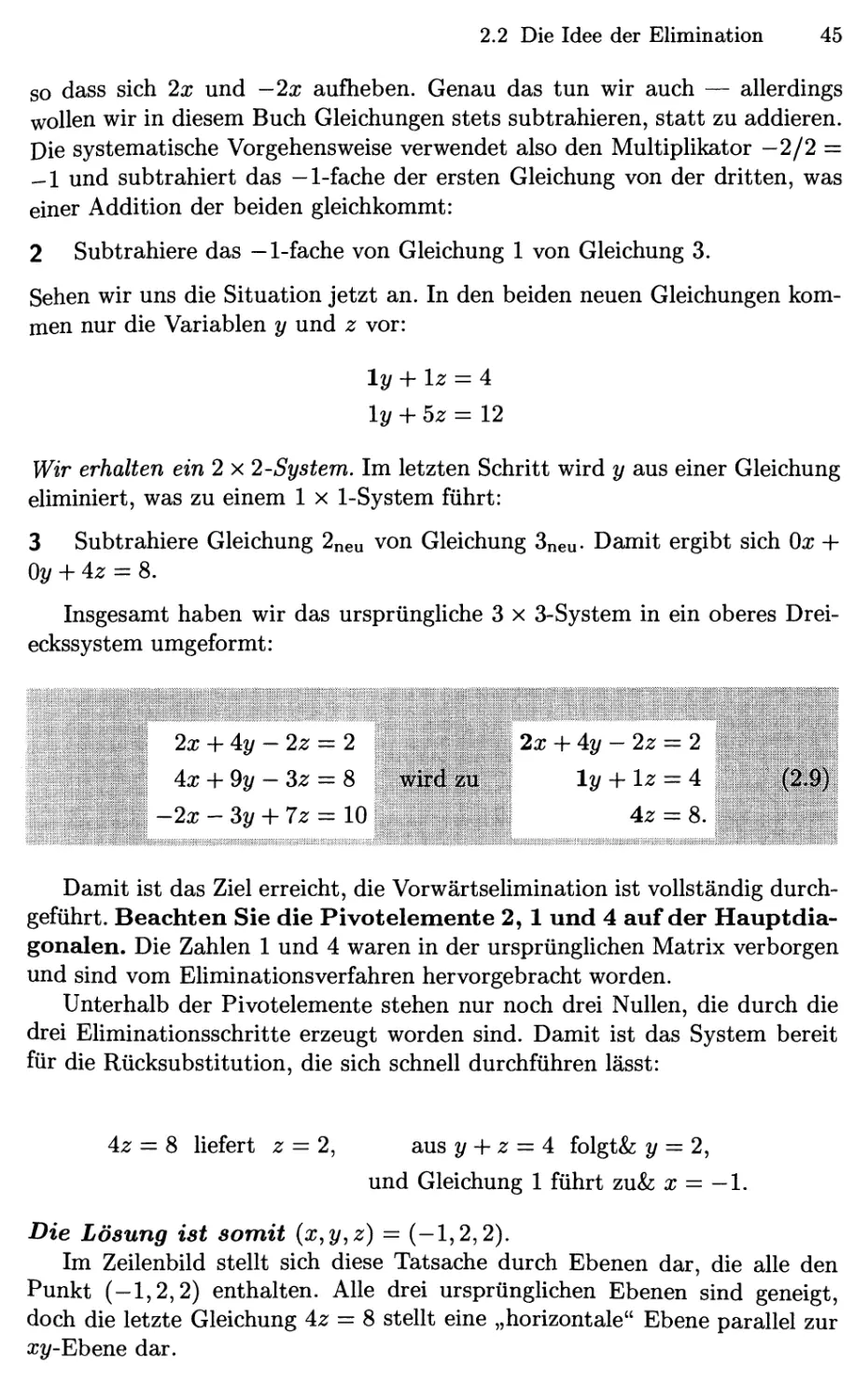

zeilenweise vorstellt, so erhält man jeweils als Produkt jeder Zeile A,0,0) mit

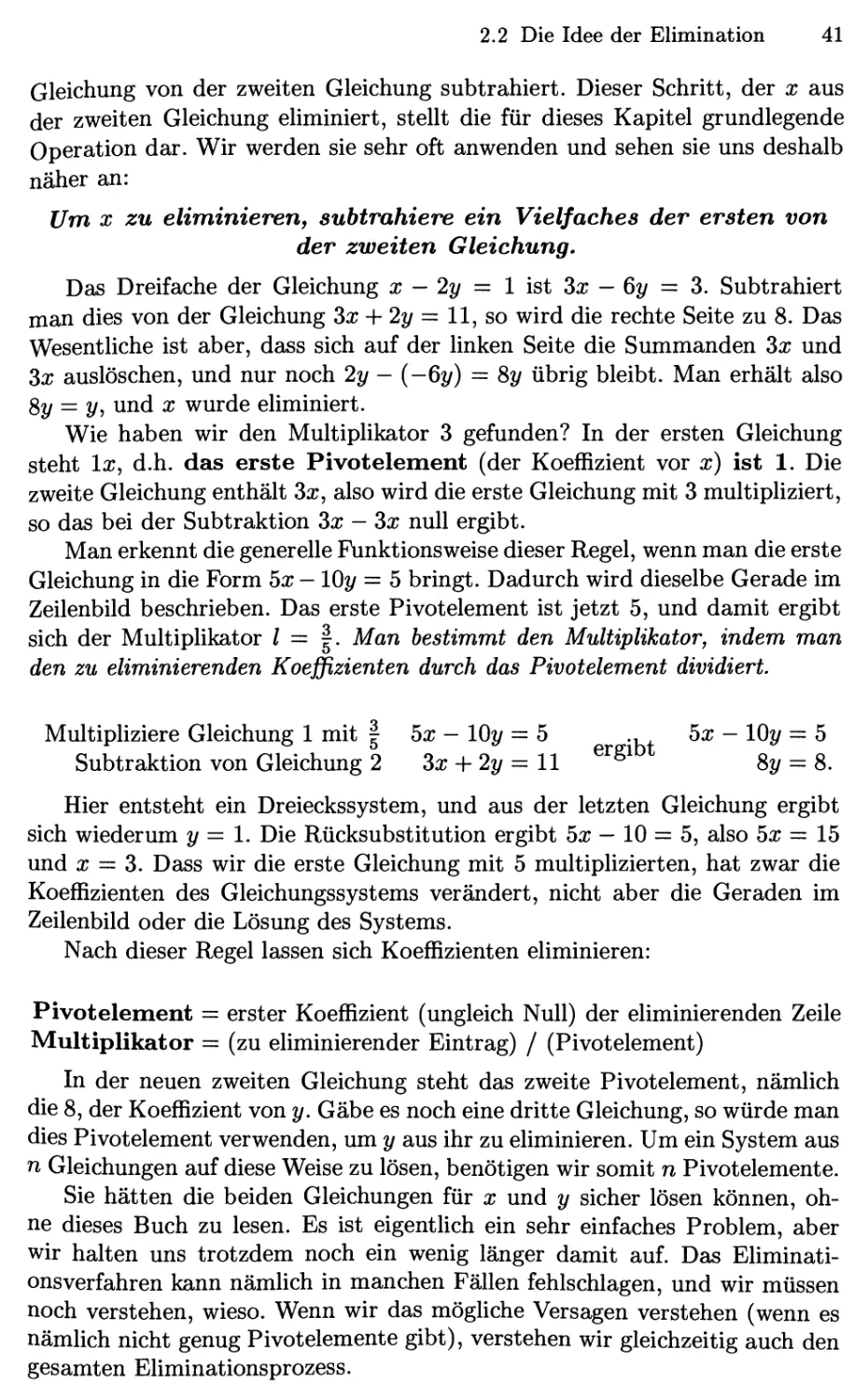

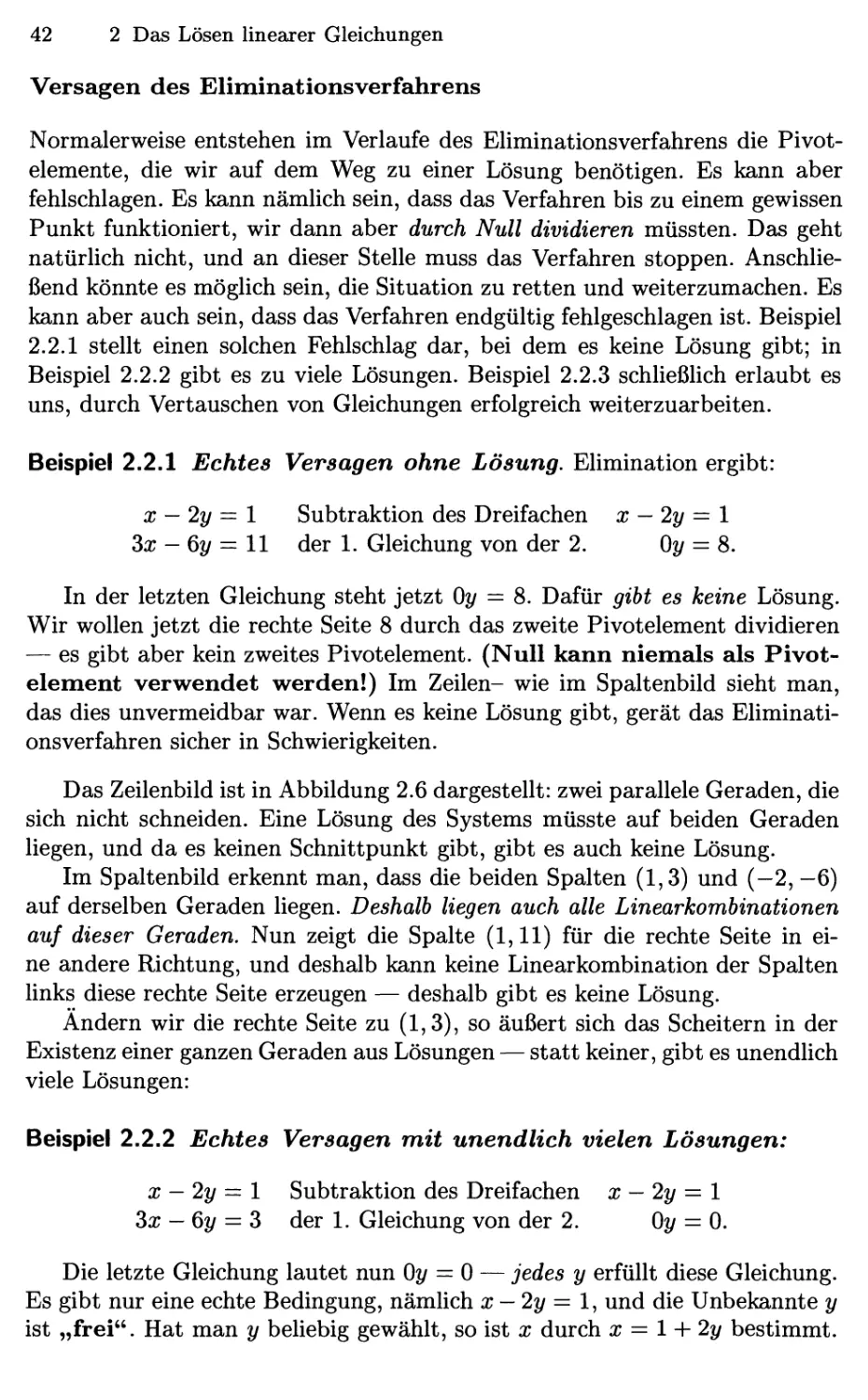

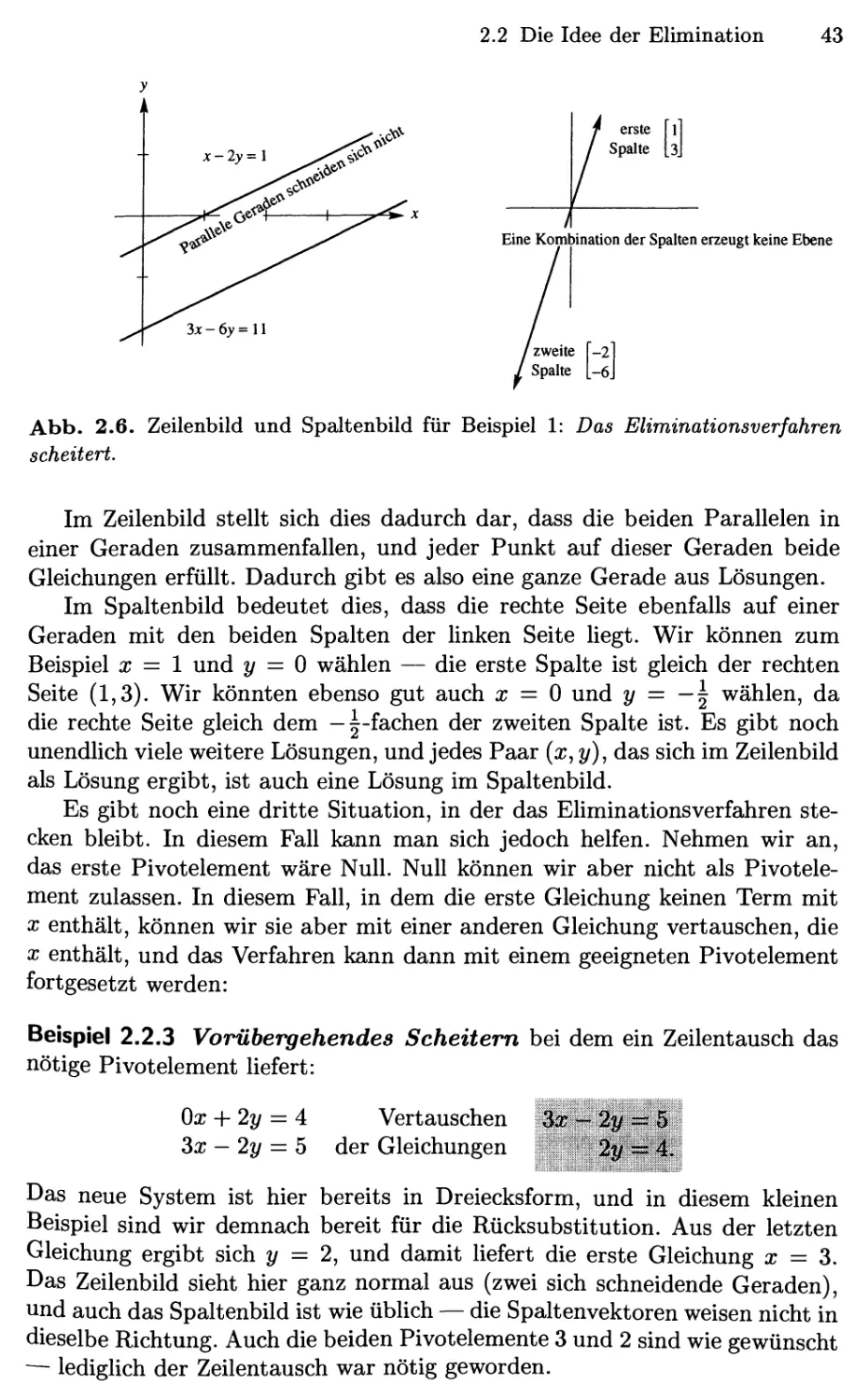

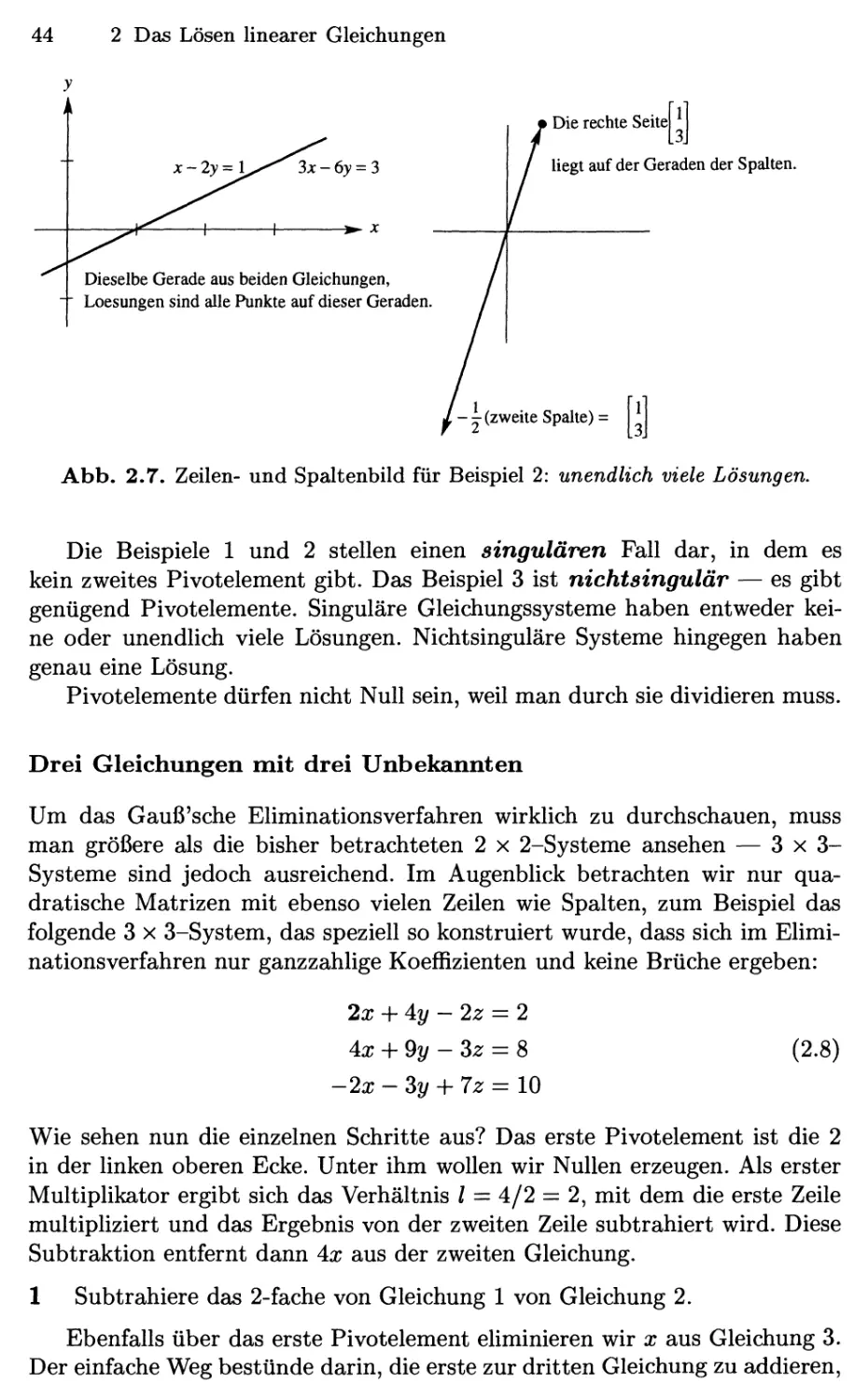

dem Vektor D,5,6) das Ergebnis 4. Geht man spaltenweise vor, so erhält man