Текст

Engineering Optimization

Methods and Applications

G. V. REKLAITIS

Chemical Engineering

Purdue University

A. RAVINDRAN

Industrial Engineering

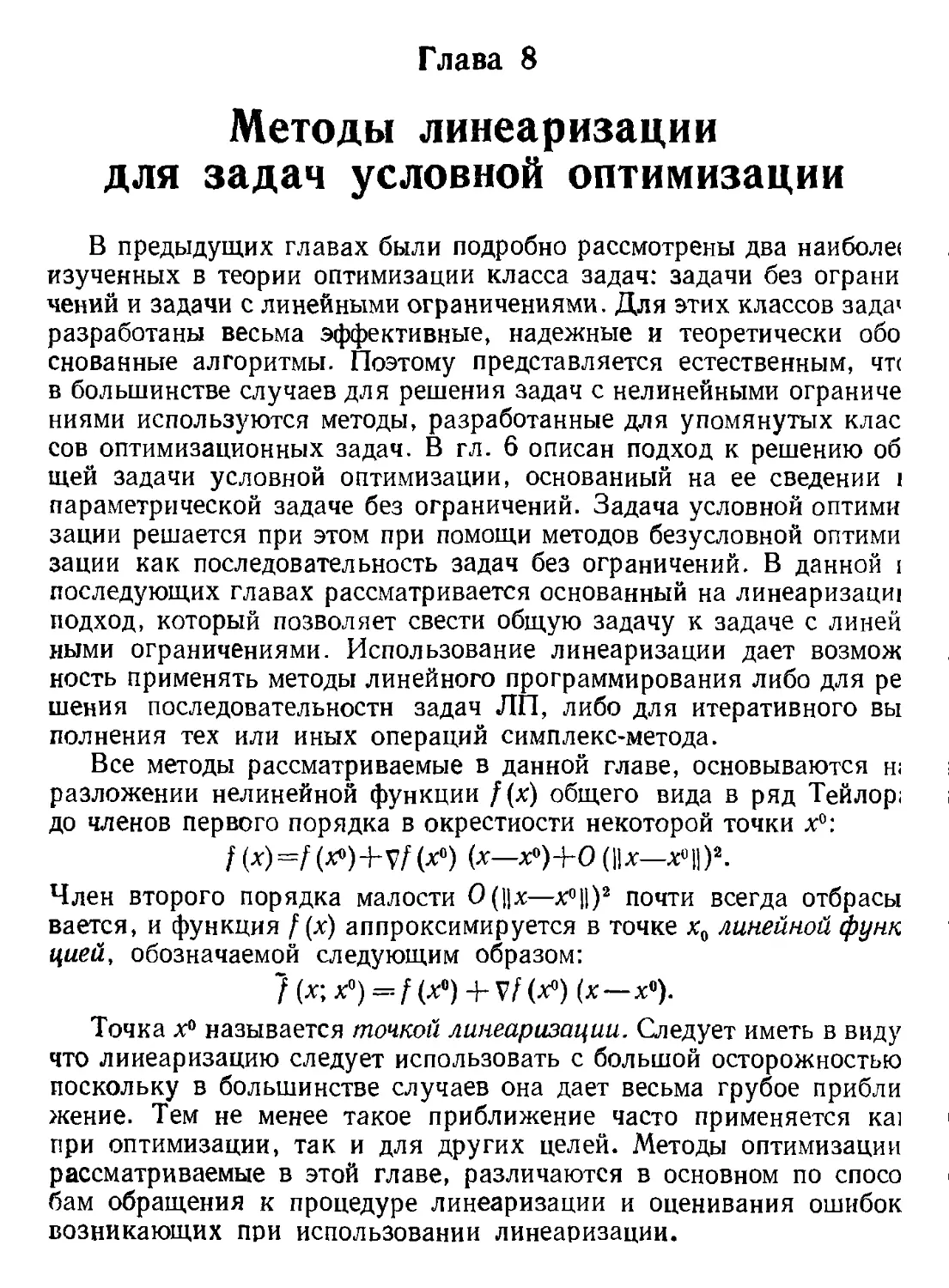

University of Oklahoma

К. M. RAGSDELL

Aerospace and Mechanical Engineering

University of Arizona

A Wiley-Interscience Publication

JOHN WILEY AND SONS

New York • Chichester • Brisbane • Toronto • Singapore

1983

Г. Рек л ей тис. АРейвиндран, К.Рэгсдел

Оптимизация в технике

В 2-х книгах

1

Перевод с английского

канд. техн, наук В. Я. Алтаева, В. И. Моторина

люсква

«МИР»

1986

ББК 22.18

Р36

УДК 519.6

Реклейтис Г., Рейвиндран А., Рэгсдел К.

Р36 Оптимизация в технике: В 2-х кн. Кн. 1. Пер. с англ.—

М.: Мир, 1986.— ООО с., ил.

Монография известных американских специалистов посвящена прикладные

аспектам теории математического программирования Рассматриваются методы ли-

нейного, целочисленного и нелинейного программирования, используемые для реше-

ния задач оптимизации технических систем, а также вопросы реализации соответ-

ствующих алгоритмов с помощью ЭВМ Изложение иллюстрируется многочислен-

ными примерами решения конкретных инженерных задач оптимизации. В русской

переводе выходит в двух книгах.

Для инженеров-конструкторов, специалистов в области проектирования техни-

ческих систем и устройств, а также преподавателей, аспирантов и студентов техни-

ческих вузов

2109000000—304

₽ 041 (01)—86

154—86, ч. 1

ББК 22. И

Редакция литературы по информатике и электронике

© 1983 John Wiley & Sons, Inc. All rights reserved

Authorized translation from English languag

edition published by John Wiley & Sons, Inc.

© перевод на русский язык, «Мир», 1986.

Предисловие к русскому изданию

Методы оптимизации эффективно применяются в самых различ-

ных областях человеческой деятельности. Особенно значительные

мнихи достигнуты при проектировании и анализе больших техни-

ческих систем. Ускоренные темпы внедрения теоретических разра-

Сннок в инженерную практику в существенной степени обусловлены

широким распространением и интенсивным совершенствованием

средств вычислительной техники.

В настоящее время для инженера ^знание методов оптимизации

является столь же необходимым, как знание основ математического

тылпза, физики, химии, теории сопротивления материалов, радио-

электроники и ряда других дисциплин, ставших традиционными.

О.чнако большинство публикаций, посвященных теоретическим и

прикладным аспектам математического программирования, как

правило, охватывают узкий круг вопросов и требуют от читателя

фундаментальной математической подготовки.

11 щание на русском языке книги Г. Реклейтиса, А. Рейвиндрана

и К. Рэгсдела окажет несомненную помощь инженерам при изуче-

нии методов оптимизации и их практическом использовании. В мо-

ши рафии последовательно излагаются методологические и вычисли-

тельные основы построения нелинейных оптимизационных моделей

технических систем. Авторам удалось четко систематизировать раз-

нообразные приемы и методы, используемые для решения задач

нелинейного программирования, раскрыть их специфические осо-

бенности, сопоставить достоинства и недостатки. Отличительной

•icpioii книги является ее практическая направленность. С большим

нед.п огическим мастерством описаны обязательные этапы оптими-

кщнонного исследования, которые, как правило, не рассматрива-

нием в обычных курсах нелинейного программирования: определе-

ние границ моделируемой технической системы, выбор приемлемого

уровня моделирования, построение целевой функции и модели в це-

пом, интерпретация оптимального решения и др. Значительный

птерес представляет сравнительный обзор алгоритмов условной

ошимизации в соответствии с критериями вычислительной эффек-

11ИП1ОСТИ и робастности [гл. 12].

Следует отметить, что многочисленные рекомендации по изуче-

нию дополнительной литературы содержат в основном ссылки на

рнбогы зарубежных авторов. Однако советские математики внесли

6 ПРЕДИСЛОВИЕ К РУССКОМУ ИЗДАНИЮ

существенный вклад в развитие теории нелинейного программирова-

ния. Из недавно вышедших в свет книг читателю можно рекомендо-

вать следующие работы: Немировский А. С., Юдин Д. Б. Слож-

ность задач и эффективность методов оптимизации.— М.: Наука,

1979; Кузнецов Ю. Н., Кузубов В. И., Волощенко А. Б. Матема-

тическое программирование.— М.: Высшая школа, 1980; Поляк Б.Т.

Введение в оптимизацию.— М.: Наука, 1983.

Книга может быть использована как учебное пособие и практи-

ческое руководство по применению методов оптимизации. Она будет

доступна и полезна широкому кругу читателей: инженерам, эко-

номистам, специалистам по математическому обеспечению ЭВМ,

преподавателям, аспирантам и студентам высших технических учеб-

ных заведений.

Канд. техн, наук В. Д. Алтаев, В. И. Моторин

Посвящается Джанин, Буване, Дженет

Предисловие

Эта книга посвящена вопросам практического применения мето-

дов оптимизации. Основное внимание уделяется методам и алгорит-

мам, используемым в инженерных приложениях при проектирова-

нии, эксплуатации и анализе функционирования технических объек-

тов. Главным образом рассматриваются методы оптимизации, ориен-

тированные на решение задач с непрерывными переменными, огра-

ничениями, содержащими действительные функции, и единственной

действительной целевой функцией, т. е. математические методы,

часто объединяемые в рамках теории нелинейного программирова-

ния. При этом дается обзор всех наиболее важных типов методоз

оптимизации, начиная от методов минимизации функции одной

переменной и кончая методами, применяемыми для решения нели-

нейных задач условной оптимизации большой размерности. Рас-

сматриваются не только классические методы, значение которых

определяется причинами исторического характера и ролью в даль-

нейшем развитии оптимизации, но также и перспективные новые

методы, примером которых может служить метод решения последо-

вательности задач квадратичного программирования.

Авторы стремились к тому, чтобы читатель получил ясное пред-

ставление о логической структуре излагаемых методов и о важней-

ших предположениях, на основе которых они разработаны, а также

об их сравнительных преимуществах и недостатках. Доказательства

и математические выкладки приводятся только в тех случаях, когда

они служат для пояснения основных шагов или свойств рассматри-

ваемых алгоритмов Как правило, при отсутствии доказательства

дается ссылка на соответствующий источник, а объем книги исполь-

зуется для обоснования и разъяснения ключевых аспектов построе-

ния различных математических схем. Таким образом, наша главная

цель заключается в том, чтобы информировать инженера о приклад-

ных возможностях методов оптимизации, а не в том, чтобы подго-

товить специалиста по математическому обеспечению ЭВМ. Поэтому

значительное внимание уделено таким практически важным вопро-

сам, как построение модели, ее реализация, подготовка к решению,

выбор первого приближения к экстремальной точке, выбор страте-

гии оптимизации и т. д. Одна из основных глав (гл. 13) посвящена

методике проведения оптимизационных исследований, в другой

главе (гл. 12) приведены результаты сравнительного анализа из-

8

ПРЕДИСЛОВИЕ

вестных программ решения оптимизационных задач на ЭВМ; в гл. 14

на трех конкретных примерах описан опыт практического приме-

нения методов оптимизации в технике. Значительная часть каждой

главы отведена примерам использования этих методов авторами

в области химической технологии, организации производства и ма-

шиностроения. Несмотря на то что имеется ряд полезных книг,

содержащих подробное изложение теоретических и вычислительных

аспектов нелинейного программирования, данная монография яв-

ляется, по-видимому, единственной в своем роде работой, которую

отличают отмеченные выше особенности: достаточно полный обзор

современных методов нелинейного программирования, неформаль-

ный подход к изложению материала и ориентация на изучение при-

кладных возможностей методов оптимизации в технике.

Работа над книгой продолжалась в течение восьми лет. За это

время материал книги использовался при чтении курса лекций по

оптимизации в технике для студентов последнего и аспирантов пер-

вого годов обучения в Университете Пурдью. Этот курс читался

в течение одного семестра; для большей части слушателей он ока-

зался первым последовательным изложением методов оптимизации.

Математическая подготовка студентов основывалась на универси-

тетских курсах математического анализа и линейной алгебры.

Таким образом, от читателя не требуется каких-либо иных знаний

в области математики. Существенное влияние на структуру книги

и методику изложения материала оказал опыт авторов, приобре-

тенный при чтении телевизионного цикла лекций по оптимизации

в технике, который передавался по местной телевизионной сети для

студентов-иностранцев и дипломированных инженеров. Поэтому

есть основания полагать, что книга может служить учебным посо-

бием как для обычных лекционных курсов, так и для телевизионных

циклов лекций, краткосрочных курсов повышения квалификации,

а также для самостоятельной работы.

Занятия по изучению материала книги были организованы

в соответствии с двумя различными программами. Первая из них

представляет собой обычный лекционный курс, рассчитанный на

45 пятидесятиминутных лекций в течение одного семестра. Вторая

программа предусматривает 30 лекций и 15 семинарских занятий.

В первом случае содержание книги можно излагать последовательно

в порядке нумерации глав, за исключением гл. 14. Во втором случае

гл. 1, 13 и 14, а также дополнительные практические примеры ре-

комендуется обсуждать на семинарах, материал гл. 2—10 и гл. 12 —

излагать в лекциях. При этом гл. И и разд. 8.3 и 9.4 приходится

обычно опускать из-за недостатка лекционного времени. Домашние

задания в обоих случаях должны включать ряд задач, приведенных

в заключительной части каждой главы и предназначенных для

решения как с помощью, так и без помощи ЭВМ. Решение задач на

ЭВМ можно осуществлять, используя программы OPTLIB, ОРТ и

BIAS, описание которых дано в гл. 12.

ПРЕДИСЛОВИЕ

9

Заметное влияние на подбор и структуру материала книги ока-

вали советы и предложения наших коллег и наставников по соот-

ветствующим дисциплинам. Число таких сознательных или неволь-

ных «участников» этой работы слишком велико, чтобы можно было

упомянуть здесь каждого из них. Проф. Дон Филипс, работавший

вместе с нами в Университете Пурдью, внес значительный вклад

в первый вариант конспектов лекций, послуживших исходным ма-

териалом для написания книги. Курс лекций и их конспекты полу-

чили одобрение бывших деканов наших факультетов: Лоуэлла Б.

Коппела, Уилбура Мейера, Р. У. Фокса и А. Г. Лефевра. Проф.

Ф. Кейхан и проф. К- Нопф, д-р Ф. У. Аренс, д-р Дж. А. Габри-

ель, д-р Р. Рут, д-р Е. Сандгрен, д-р П. В. Сарма, Брэд Овертерф

и Мохайндер Суд, а также П. К. Эсуаран, Дж. Поузи и Б. Нельсон

внесли целый ряд поправок и улучшений. Мы признательны также

нашим студентам, настойчиво проработавшим различные варианты

рукописи, за многочисленные вопросы и просьбы о пояснении тех

или иных результатов. Их подчас острые, но, как правило, справед-

ливые критические высказывания служили отличным стимулом

к совершенствованию материала книги. Наконец, хотелось бы вы-

разить благодарность редактору книги Фрэнку Серра и его пред-

шественнику Мейеру Кутцу за их настойчивость и терпение. Мы

благодарны нашим женам и детям, позволившим нам тратить время

на написание книги, за поддержку в течение всей работы.

Г. Реклейтис

А. Рейвиндран

К. Рэгсдел

Уэст-Лафайетт, Индиана,

лето 1983 года

Глава 1

Методологические основы

оптимизации

Данная книга является введением в теорию оптимизации и зна-

комит с приложениями этой теории к решению ряда задач, возни-

кающих в инженерной практике. В наиболее общем смысле теория

оптимизации представляет собой совокупность фундаментальных

математических результатов и численных методов, ориентированных

на нахождение и идентификацию наилучших вариантов из множества

альтернатив и позволяющих избежать полного перебора и оценива-

ния возможных вариантов. Процесс оптимизации лежит в основе

всей инженерной деятельности, поскольку классические функции

инженера заключаются в том, чтобы, с одной стороны, проектиро-

вать новые, более эффективные и менее дорогостоящие технические

системы и, с другой стороны, разрабатывать методы повышения

качества функционирования существующих систем.

Эффективность оптимизационных методов, позволяющих осу-

ществить выбор наилучшего варианта без непосредственной про-

верки всех возможных вариантов, тесно связана с широким исполь-

зованием достижений в области математики путем реализации

итеративных вычислительных схем, опирающихся на строго обосно-

ванные логические процедуры и алгоритмы, на базе применения

вычислительной техники. Поэтому для изложения методологиче-

ских основ оптимизации требуется привлечение важнейших резуль-

татов теории матриц, элементов линейной алгебры и дифференциаль-

ного исчисления, а также положений математического анализа.

Математические понятия и конструкции используются в настоящей

книге не только для того, чтобы повысить уровень строгости пред-

ставления материала, но и потому, что они составляют- терминоло-

гическую базу изложения, которая позволяет упростить описание

и определение структурных элементов рассматриваемых вычисли-

тельных процедур и облегчить их понимание.

Поскольку размерность инженерных задач, как правило, до-

статочно велика, а расчеты в соответствии с алгоритмами оптими-

зации требуют значительных затрат времени, оптимизационные ме-

тоды ориентированы главным образом на реализацию с помощью

ЭВМ. Однако несмотря на то, что изложение методологических

принципов ведется в книге с учетом указанной ориентации, авторы

МЕТОДОЛОГИЧЕСКИЕ ОСНОВЫ ОПТИМИЗАЦИИ

И

не сочли целесообразным подробно останавливаться на вопросах,

связанных с составлением программ для ЭВМ и программированием.

Главное внимание в книге уделяется математическим и логическим

построениям, лежащим в основе исследуемых методов, факторам,

обусловливающим выбор тех или иных аналитических схем, а таю

же рассмотрению важнейших прикладных аспектов теории.

1.1. Необходимые условия для применения

оптимизационных методов

Для того чтобы использовать математические результаты и чис-

ленные методы теории оптимизации для решения конкретных инже-

нерных задач, необходимо установить границы подлежащей опти-

мизации инженерной системы, определить количественный критерий,

на основе которого можно произвести анализ вариантов с целью

выявления «наилучшего», осуществить выбор внутрисистемных пе-

ременных, которые используются для определения характеристик

и идентификации вариантов, и, наконец, построить модель, отра-

жающую взаимосвязи между переменными. Эта последовательность

действий составляет содержание процесса постановки задачи ин-

женерной оптимизации. Корректная постановка задачи служит

ключом к успеху оптимизационного исследования и ассоциируется

в большей степени с искусством, нежели с точной наукой. Искусство

постановки задач постигается в практической деятельности на при-

мерах успешно реализованных разработок и основывается на четком

представлении преимуществ, недостатков и специфических особен-

ностей различных методов теории оптимизации. По этим причинам

изложение материала книги сопровождается большим количеством

практических примеров, заимствованных из специальной литера-

туры, а также построенных авторами на основе собственного инже-

нерного опыта. Кроме того, наряду с описанием оптимизационных

методов в книге освещаются вопросы, касающиеся их относительных

преимуществ и недостатков; в ряде случаев приводятся результаты

расчетов, подтверждающие обоснованность сделанных выводов, и

даются ссылки на соответствующие публикации.

Последующие подразделы посвящены более подробному рас-

смотрению этапов постановки задачи, которое завершается

в разд. 1.2 анализом формулировок нескольких практических

задач.

1.1.1. Определение границ системы

Прежде чем приступить к оптимизационному исследованию,

важно четко определить границы изучаемой системы. В данном

контексте система предстает как некоторая изолированная часть

реального мира. Границы системы задаются пределами, отделяю-

щими систему от внешней среды, и служат для выделения системы

12

ГЛАВА I

из ее окружения. При проведении анализа обычно предполагается,

что взаимосвязи между системой и внешней средой зафиксированы

на некотором выбранном уровне представления. Тем не менее,

поскольку такие взаимосвязи всегда существуют, определение гра-

ниц системы является первым шагом в процессе приближенного

описания реальной системы.

В ряде случаев может оказаться, что первоначальный выбор

границы является слишком жестким. Для более полного анализа

данной инженерной системы может возникнуть необходимость рас-

ширения установленных границ системы путем включения других

подсистем, оказывающих существенное влияние на функционирова-

ние исследуемой системы. Предположим, например, что на промыш-

ленном предприятии имеется красильный цех, в котором готовые

изделия поступают на поточную линию и окрашиваются в различ-

ные цвета. На первой стадии изучения красильного цеха можно

рассматривать его изолированно от других цехов предприятия.

Однако анализ может показать, что оптимальный размер партии

изделий и последовательность нанесения красителей в существен-

ной степени зависят от особенностей функционирования производ-

ственного цеха, в котором выпускаются готовые изделия. Таким

образом, возникает необходимость принять решение о расширении

границ системы путем включения в нее производственного цеха.

Разумеется, расширение границ системы повышает размерность и

сложность многокомпонентной системы и, следовательно, в значи-

тельной мере затрудняет ее анализ. Очевидно, что в инженерной

практике следует, насколько это возможно, стремиться к разбиению

больших сложных систем на относительно небольшие подсистемы,

которые можно изучать по отдельности. Однако при этом необхо-

димо иметь уверенность в том, что такая декомпозиция не приведет

к излишнему упрощению реальной ситуации.

1.1.2. Характеристический критерий

Если подлежащая исследованию система определена и ее границы

установлены, то на следующем этапе постановки задачи оптимизации

необходимо осуществить выбор критерия, на основе которого можно

оценить характеристики системы или ее проекта, с тем чтобы вы-

явить «наилучший» проект или множество «наилучших» условий

функционирования системы. В инженерных приложениях обычно

выбираются критерии экономического характера. Однако спектр

возможных формулировок таких критериев весьма широк; при

определении критерия могут использоваться такие экономические

характеристики, как валовые капитальные затраты, издержки

в единицу времени, чистая прибыль в единицу времени, доходы от

инвестиций, отношение затрат к прибыли или собственный капитал

на данный момент времени. В других приложениях критерий может

основываться на некоторых технологических факторах, например,

МЕТОДОЛОГИЧЕСКИЕ ОСНОВЫ ОПТИМИЗАЦИИ

13

когда требуется минимизировать продолжительность процесса про-

изводства изделия, максимизировать темпы производства, миними-

зировать количество потребляемой энергии, максимизировать ве-

личину крутящего момента, максимизировать нагрузку и т. п.

Независимо от того, какой критерий выбирается при оптимизации,

«наилучшему» варианту всегда соответствует минимальное или мак-

симальное значение характеристического показателя качества функ-

ционирования системы.

Важно отметить, что независимо от содержания оптимизацион-

ных методов, рассматриваемых в настоящей книге, только один

критерий (и, следовательно, характеристическая мера) может ис-

пользоваться при определении оптимума, так как невозможно по-

лучить решение, которое, например, одновременно обеспечивает

минимум затрат, максимум надежности и минимум потребляемой

энергии. Здесь мы опять сталкиваемся с существенным упрощением

реальной ситуации, поскольку в ряде практических случаев было

бы весьма желательным найти решение, которое бы являлось «наи-

лучшим» с позиций нескольких различных критериев.

Один из путей учета совокупности противоречивых целевых уста-

новок состоит в том, что какой-либо из критериев выбирается в ка-

честве первичного, тогда как остальные критерии считаются вто-

ричными. В этом случае первичный критерий испрльзуется при

оптимизации как характеристическая мера, а вторичные критерии

порождают ограничения оптимизационной задачи, которые уста-

навливают диапазоны изменений соответствующих показателей от

минимального до максимального приемлемого значения. В част-

ности, в примере с красильным цехом различными служащими фир-

мы, которой принадлежит промышленное предприятие, могут быть

выбраны следующие критерии.

1. Управляющий красильным цехом отдает предпочтение про-

екту, согласно которому производственный процесс протекает

с минимальными изменениями в ассортименте изделий и исполь-

зуемых красок. При этом максимизируется количество изделий,

окрашиваемых в единицу времени.

2. Руководитель отдела сбыта заинтересован в реализации

проекта, в соответствии с которым объемы складских запасов изде-

лий всех видов и окрасок максимальны. В этом случае минимизи-

руется продолжительность интервала времени между получением

заказа от потребителя и его выполнением.

3. Руководитель фирмы отдает предпочтение проекту, в соот-

ветствии с которым объемы складских запасов минимальны, с тем

чтобы уменьшить капитальные издержки на хранение изделий.

Нетрудно видеть, что эти критерии не могут быть реализованы

при оптимизации одновременно. Приемлемым компромиссом явля-

ется выбор в качестве первичного характеристического показателя

качества функционирования системы подлежащего минимизации

показателя суммарных затрат в единицу времени с последующим

14

ГЛАВА 1

учетом необходимых вторичных условий, к числу которых отно-

сится поддержание объемов складских запасов изделий всех видов

в заранее установленных границах, а также ограничение количества

изменений в ассортименте изделий и используемых красок в тече-

ние недели.

В заключение отметим, что для применения рассматриваемых

в книге методов необходимо сформулировать оптимизационную зада-

чу, которая обладает единственным характеристическим критерием.

За последние годы разработан ряд методов решения мультикритери-

альных оптимизационных задач различных типов, однако обсуж-

дение этого нового и постоянно совершенствуемого аналитического

аппарата выходит за рамки данной книги. Заинтересованный чита-

тель может обратиться к недавно вышедшим в свет специальным

работам [1, 2].

1.1.3. Независимые переменные

На третьем основном этапе постановки задачи оптимизации осу-

ществляется выбор независимых переменных, которые должны

адекватно описывать допустимые проекты или условия функциони-

рования системы. В процессе выбора независимых переменных

следует принять во внимание ряд важных обстоятельств, которые

рассматриваются ниже.

Во-первых, необходимо провести различие между переменными,

значения которых могут изменяться в достаточно широком диапазо-

не, и переменными, значения которых фиксированы и определяются

внешними факторами. Так, в примере с красильным цехом виды

изделий и сорта применяемых красок зафиксированы технологиче-

скими спецификациями или заказами потребителей, т. е. относятся

к числу параметров системы. С другой стороны, порядок окраски

изделий в различные цвета с учетом ограничений, накладываемых

на количество видов изделий и объемы складских запасов, пред-

ставляется независимой переменной, значения которой могут варьи-

роваться при заданной производственной программе.

Далее важно провести различие между теми параметрами сис-

темы, которые могут предполагаться постоянными, и параметрами,

которые подвержены флуктуациям вследствие воздействия внешних

или неконтролируемых факторов. В частности, в примере с красиль-

ным цехом поломки оборудования и прогулы рабочих могут ока-

зать весьма заметное влияние на процесс производства в цехе.

Ясно, что существенные изменения этих важных параметров систе-

мы должны быть приняты во внимание при постановке задачи про-

изводственного планирования, если требуется, чтобы составленный

оптимальный план был реалистичным и выполнимым.

Во-вторых, при постановке задачи следует учитывать все основ-

ные переменные, которые влияют на функционирование системы

или качество проекта. Например, если при проектировании газо-

МЕТОДОЛОГИЧЕСКИЕ ОСНОВЫ ОПТИМИЗАЦИИ

15

хранилища рассматривать высоту, диаметр и толщину стенок ци-

линдрического газгольдера как независимые переменные, но исклю-

чить возможность использования компрессора для повышения ра-

бочего давления, то получится проект весьма низкого качества. Для

выбранной и фиксированной величины давления, разумеется, можно

определить размеры газгольдера, обеспечивающие его наименьшую

стоимость. Однако если включить в число независимых переменных

давление, при котором хранится газ, и ввести в характеристический

критерий стоимость компрессора, то можно получить проект, реа-

лизация которого,требует меньших полных затрат из-за уменьшения

необходимого объема газгольдера. Следовательно, независимые

переменные должны выбираться таким образом, чтобы все важней-

шие технико-экономические решения нашли отражение в формули-

ровке задачи. Исключение возможных альтернатив в общем случае

приводит к получению субоптимальных решений.

Наконец, еще одним существенным фактором, влияющим на вы-

бор переменных, является уровень детализации при исследовании

системы. Очень важно ввести в рассмотрение все основные незави-

симые переменные, но не менее важно не «перегружать» задачу боль-

шим количеством мелких, несущественных деталей. Например, при

проведении предварительного анализа производственного процесса,

включающего большое число различных видов оборудования—

сосудов высокого давления, колонн, насосов, компрессоров и тепло-

обменников,— обычно явным образом не учитываются несуществен-

ные особенности конструкции того или иного устройства. Теплооб-

менник может быть с достаточной для поставленных целей полнотой

охарактеризован как размерами площади поверхности теплопере-

дачи, так и перепадами давления в трубах и корпусе аппарата.

Переменные, имеющие непосредственное отношение к конструкции

аппарата,— количество и размеры труб, число проходов труб через

корпус, частота расположения перегородок и размеры корпуса —

рассматриваются, как правило, при исследовании каждого отдель-

ного устройства. При выборе независимых переменных целесооб-

разно руководствоваться правилом, согласно которому следует

рассматривать только те переменные, которые оказывают суще-

ственное влияние на характеристический критерий, выбранный для

анализа сложной системы.

1.1.4. Модель системы

После того как характеристический критерий и независимые

переменные выбраны, на следующем этапе постановки задачи необ-

ходимо построить модель, которая описывает взаимосвязи между

переменными задачи и отражает влияние независимых переменных

на степень достижения цели, определяемой характеристическим

критерием. В принципе оптимизационное исследование можно про-

вести на основе непосредственного экспериментирования с системой.

16

ГЛАВА 1

Для этого следует зафиксировать значения независимых внутри-

системных переменных, реализовать процедуру наблюдения за

функционированием системы в этих условиях и оценить значение

характеристического показателя качества функционирования систе-

мы, исходя из зарегистрированных характеристик. Затем с помощью

оптимизационных методов можно скорректировать значения неза-

висимых переменных и продолжить серию экспериментов. Однако

на практике оптимизационные исследования проводятся, как пра-

вило, на основе упрощенного математического представления сис-

темы, которое носит название модели. Применение моделей обуслов-

лено тем, что эксперименты с реальными системами обычно требуют

слишком больших затрат средств и времени, а также в ряде случаев

оказываются связанными с риском. Модели широко используются

при инженерном проектировании, поскольку это открывает воз-

можности для реализации наиболее экономичного способа изучения

влияния изменений в значениях основных независимых переменных

на показатель качества функционирования системы.

В самом общем представлении структура модели включает ос-

новные уравнения материальных и энергетических балансов, соот-

ношения, связанные с проектными решениями, а также уравнения,

описывающие физические процессы, протекающие в системе. Эти

уравнения обычно дополняются неравенствами, которые определяют

область допустимых значений независимых переменных, позволяют

определить требования, накладываемые на верхние или нижние

границы изменения характеристик функционирования системы, и

установить лимиты имеющихся ресурсов. Таким образом, элементы

модели содержат всю информацию, которая обычно используется

при расчете проекта или прогнозировании характеристик инженер-

ной системы. Очевидно, что процесс построения модели является

весьма трудоемким и требует четкого понимания специфических

особенностей рассматриваемой системы. В последующих главах

вопросы конструирования моделей будут рассмотрены более под-

робно. Здесь же целесообразно ограничиться констатацией того

факта, что модель представляет собой некоторый набор уравнений

и неравенств, которые определяют взаимосвязь между переменными

системы и ограничивают область допустимых изменений пере-

менных.

Из вышеизложенного следует, что задача в виде, пригодном для

применения оптимизационных методов, объединяет характеристи-

ческую меру, множество независимых переменных и модель, отра-

жающую взаимосвязь переменных. Поскольку требования, предъ-

являемые к оптимизационным задачам, являются весьма общими и

носят абстрактный характер, область приложения методов оптими-

зации может быть достаточно широкой. Действительно, рассматри-

ваемые ниже методы находят применение при решении самых раз-

личных задач науки и техники, включая задачи оптимального про-

ектирования структурных элементов систем и процессов, планиро-

МЕТОДОЛОГИЧЕСКИЕ ОСНОВЫ ОПТИМИЗАЦИИ

17

вания стратегий капитальных вложений, компоновки сетей склад-

ских помещений, определения оптимальных маршрутов движения

грузового транспорта, планирования в здравоохранении, дислока-

ции вооруженных сил, проектирования механических узлов и ряд

других задач. В данной книге основное внимание уделяется инже-

нерным приложениям. Некоторые из приложений такого рода

вместе с постановками соответствующих задач рассматриваются

в следующем разделе.

1.2. Применение методов оптимизации

в инженерной практике

Теория оптимизации находит эффективное применение во всех

1 направлениях инженерной деятельности, и в первую очередь в сле-

дующих четырех ее областях:

1) проектирование систем и их составных частей;

> 2) планирование и анализ функционирования существующих

- систем;

3) инженерный анализ и обработка информации;

4) управление динамическими системами.

В данном разделе кратко рассматриваются типичные приложе-

ния методов оптимизации в каждой из первых трех перечисленных

областей.

Такая важная область инженерной деятельности, как управ-

ление динамическими системами, также допускает применение

методов оптимизации, однако анализ соответствующих примеров

требует от читателя специальной подготовки и выходит за рамки

этой книги.

При рассмотрении приложений методов оптимизации при проек-

тировании и анализе функционирования систем следует иметь

в виду, что оптимизация — всего лишь один этап в процессе фор-

мирования оптимального проекта или условий эффективного функ-

ционирования системы. Вообще говоря, указанный процесс, как

показано на рис. 1.1, является циклическим и включает синтез

(определение) структуры системы, построение модели, оптимизацию

параметров модели и анализ полученного решения. При этом опти-

мальный проект или новый план функционирования системы строит-

ся на основе решения серин оптимизационных задач, способствую-

щего дальнейшему совершенствованию структуры системы. Для

краткости изложения рассматриваемые в данном разделе примеры

иллюстрируют лишь один цикл процесса проектирования и связаны

главным образом с подготовкой к этапу оптимизации. Такую ориен-

тацию примеров не следует интерпретировать как подчеркивание

ведущей роли оптимизационных методов в инженерном проектиро-

вании и в процессе анализа систем. Несмотря на то что методы теории

оптимизации отличаются универсальностью, их успешное приме-

18

ГЛАВА 1

Инженерное

проектирование

I

Определение потребностей

и установление лимитов

ресурсов

Постановка задачи

Построение модели

Анализ

।

Рычнсленил U

Рис 1 1. Этапы процесса инженерного проектирования.

нение в значительной степени зависит от профессиональной подго-

товки инженера, который должен иметь четкое представление о спе-

цифических особенностях изучаемой системы. Основная цель рас-

смотрения приводимых ниже примеров заключается в том, чтобь

продемонстрировать разнообразие постановок оптимизационных

задач, возникающих в процессе проектирования и анализа, на фоне

общности их формы.

МЕТОДОЛОГИЧЕСКИЕ ОСНОВЫ ОПТИМИЗАЦИИ

19

1.2.1. Использование методов оптимизации

при проектировании

Сфера применения оптимизационных методов в инженерном про-

ектировании достаточно широка: от проектирования отдельных

структурных элементов технических систем до проектирования узлов

оборудования и составления предварительных проектов промыш-

ленных предприятий в целом. Для того чтобы использовать методы

оптимизации, необходимо разработать «принципиальную схему»

функционирования системы или выявить ее структуру; тогда задача

оптимизации сводится к выбору таких значений переменных, харак-

теризующих размеры отдельных устройств и режимы их работы,

которым соответствует наилучшее значение характеристического

показателя качества функционирования системы.

Пример 1.1. Проектирование системы снабжения кислородом

Описание задачи. Кислородный конвертер, используе-

мый в производстве стали, представляет собой химический реактор

периодического действия, который потребляет чистый кислород.

Процесс функционирования конвертера — циклический. Руда и

D,

Скорость

потребления

фунт 02

час

F

—— Время - >

Цикл потребления кислорода, пример 1.1.

о < t <

Рис 1.2.

{Do при

Dj при

< t < /2,с повторением в каждом цикле длины t2

флюс загружаются в реактор, взаимодействуют в течение определен-

ного периода времени, а затем продукты взаимодействия выводятся

наружу. Этот циклический процесс связан с периодическими изме-

нениями скорости потребления кислорода. Как показано на рис. 1 2,

каждый цикл состоит из временного интервала длины tlt на котором

расход кислорода в единицу времени невелик и равен Do> и времен-

ного интервала (£2—G), которому соответствует высокая скорость

потребления Dx. Используемый в конвертере кислород производится

на специальной установке в соответствии с распространенным тех-

нологическим способом, который позволяет получать кислород из

20

ГЛАВА 1

воздуха путем охлаждения и дистилляции. Кислородные установки

отличаются высоким уровнем автоматизации и, как правило, имеют

постоянную производительность. Для того чтобы соединить непре-

рывно действующую кислородную установку с циклически функцио-

нирующим конвертером, необходимо разработать проект простой

системы управления запасами (рис. 1.3), состоящей из компрессора

и резервуара для хранения кислорода. Рассмотрим возможные

Рис. 1.3. Проект системы снабжения кислородом, пример 1.1.

проекты. В самом простом случае производительность кислородной

установки можно выбрать равной D15 наибольшей скорости потреб-

ления кислорода. В течение интервала времени, которому соответ-

ствует низкий расход кислорода, излишек газа придется выпускать

в атмосферу. С другой стороны, можно выбрать кислородную уста-

новку с такой производительностью, которая позволила бы в тече-

ние одного цикла получать количество кислорода, требуемое для

обеспечения нормальной работы конвертера. В интервале времени,

когда расход газа невелик, излишек кислорода под давлением на-

капливался бы в резервуаре для последующего использования в те-

чение интервала времени, которому соответствует высокая скорость

потребления. Все промежуточные проекты отличаются от рассмот-

ренных различными сочетаниями запасов и потерь кислорода. За-

дача заключается в том, чтобы выбрать оптимальный проект.

Постановка задачи. Изучаемая система состоит из

установки для производства кислорода, компрессора и резервуара

для хранения газа. Характеристики кислородного конвертера и

цикла потребления кислорода предполагаются заданными, так как

определяются внешними по отношению к системе факторами. Ха-

рактеристический показатель качества проекта естественно выбрать

в виде полных затрат в единицу времени, которые включают затраты

на производство кислорода (постоянные и переменные), затраты на

эксплуатацию компрессора, а также постоянные издержки, свя-

занные с приобретением компрессора и резервуара для хранения

МЕТОДОЛОГИЧЕСКИЕ ОСНОВЫ ОПТИМИЗАЦИИ

21

кислорода. Основными независимыми переменными являются про-

и шодительность кислородной установки F (кг О2/ч), проектная

мощность компрессора Н (л. с.), проектная емкость резервуара

(м3) и максимальное давление в резервуаре р (Н/м2). Предпола-

1ается, что кислородная установка является стандартной и поэтому

полностью характеризуется своей производительностью. Кроме

ни о, предполагается также, что резервуар отвечает требованиям

обычного проекта и предназначен для хранения кислорода.

Модель системы включает основные соотношения, с помощью

которых можно описать взаимосвязи между независимыми перемен-

ными.

Пусть /макс— максимальное количество кислорода, запасенного

и резервуаре; используя скорректированное уравнение газового

состояния, получим

К=(/макс/М)(7?Т/р)г, (1.1)

1 де R — универсальная газовая постоянная, Т — температура газа

(предполагается постоянной), z— коэффициент сжимаемости, М. —

молекулярный вес кислорода.

Из рис. 1.2 следует, что максимальное количество кислорода,

которое должно быть запасено в резервуаре, равняется площади,

ограниченной кривой потребления между точками tx и t2, Dx и F.

Таким образом,

lMailc=(D1-F)(t2-t1). (1.2)

Подставив выражение (1.2) в (1.1), получим

у (Pi—F)(t2—ti) RT /141

v — M p z- U

Конструкция компрессора должна обеспечивать управление

потоком газа, обладающим скоростью (Dt—F) (t2—и повыше-

ние давления газа до максимального значения р. В предположении,

что газ идеальный, а процесс сжатия изотермический, имеем [3J

Я = (Pi^F)_(y.2-(i)_ RT 1п_^ ,

р0 v '

где — переводной коэффициент, k2— коэффициент полезного дей-

ствия компрессора, ра— начальное давление кислорода.

Уравнения (1.3) и (1.4) необходимо дополнить неравенством,

устанавливающим, что производительность кислородной установки

F не должна быть меньше средней скорости потребления кислорода,

т. е. неравенством

Р (it— ti) (। 5)

Кроме того, максимальное давление в резервуаре должно превышать

начальное давление кислорода:

Р>Ро- (1.6)

22

ГЛАВА 1

Характеристический показатель качества проекта включает

затраты на производство кислорода:

Ci (долл./год) —ai+a^F, (1.7)

где и а2— эмпирически определяемые параметры для установок

рассматриваемого типа, связанные с затратами на топливо, воду и

рабочую силу.

Капитальные затраты на приобретение резервуара для хранения

кислорода находятся с помощью следующей степенной зависимости:

С2 (долл.)=5, УЧ (1.8)

где и Ьг— эмпирически определяемые постоянные, отражающие

специфические особенности конструкции резервуара. Капитальные

затраты, связанные с приобретением компрессора, вычисляются

с помощью аналогичной формулы:

Сз(долл.)=&3//йп (1.9)

Затраты на эксплуатацию компрессора приближенно описывают-

ся выражением bd^H, где Ь&— затраты на эксплуатацию компрессора

единичной мощности в единицу времени. Таким образом, функцию

полных издержек можно записать в следующем виде:

Полные годовые затраты — a1+a2F+d{b1Vb!jrb3ffbi}-}-Nbii1H,

(1.Ю)

где N — число циклов потребления кислорода, реализуемых в те-

чение года, d — весовой коэффициент.

Задача оптимизации заключается в том, чтобы минимизировать

функцию (1.10) путем соответствующего выбора значений F, V,

Нир, удовлетворяющих уравнениям (1.3) и (1.4), а также неравен-

ствам (1.5) и (1.6).

Решение сформулированной задачи в существенной степени за-

висит от выбора параметров цикла (IV, ЕЕ, Dt, Л и t2), стоимостных

параметров (alt а2, Ьг—Ьъ и d) и физических параметров (Т, ра, k2,

г и /И).

В принципе эту задачу можно решить путем исключения V и Н

из формулы (1.10) с помощью (1.3) и (1.4); в результате получается

задача с двумя переменными. Если затем изобразить линии уровня

функции полных затрат на плоскости с координатами F и р, а также

учесть неравенства (1.5) и (1.6), то можно найти точку минимума.

Однако методы, рассматриваемые в последующих главах книги,

позволяют получить решение с гораздо меньшими затратами труда.

Более подробно вопросы, связанные с решением задач с различными

значениями параметров, освещены в работе [4].

В примере 1.1 представлена постановка задачи предварительногс

проектирования системы, состоящей из нескольких агрегатов. Сле-

дующий пример иллюстрирует процесс проектирования отдельногс

структурного элемента системы.

МЕТОДОЛОГИЧЕСКИЕ ОСНОВЫ ОПТИМИЗАЦИИ

23

Пример 1.2. Проектирование нагруженной балки

Описание задачи. Балка А крепится на жесткой опоре

В с помощью сварного соединения. Балка изготавливается из стали

марки 1010 и должна выдерживать нагрузку F=6000 фунт. Размеры

балки выбираются таким образом, чтобы полные затраты были ми-

нимальными. Схематический чертеж системы приведен на рис. 1.4.

Рис. 1.4. Нагруженная балка, пример 12.

Постановки задачи. Определение границ системы

в данном случае является тривиальной задачей. Система состоит из

балки А и сварного шва, необходимого для прикрепления балки

к опоре В. Независимыми, или управляемыми, переменными служат

размеры h, I, t и b, которые показаны на рис. 1.4. Длина балки L

предполагается равной 14 дюйм. Для удобства записи представим

введенные переменные как компоненты неизвестного вектора х:

х=[х1( х2, х3, x]4T=[h, I, t, b]T.

Характеристическим показателем качества проекта служат за-

траты на построение сварной группы. Основными стоимостными ха-

рактеристиками такой группы являются (1) затраты на подготови-

тельные работы, (2) затраты на сварочные работы и (3) стоимость

материалов, т. е.

F (х)=с0+с1+с2,

где F (х) — функция затрат, с0— затраты на подготовительные рабо-

ты; Ci— затраты на сварочные работы, с2— стоимость материалов.

Затраты на подготовительные работы с0. Решение о проектиро-

вании рассматриваемого структурного элемента в виде сварного

узла было основано на наличии аппарата для сварки прямолиней-

ным швом у заказчика проекта. Далее предположим, что все устрой-

ства, необходимые для установки и поддержания балки в положе-

нии, удобном для проведения сварочных работ, также имеются

в наличии. В этом случае затраты с0 можно не учитывать при по-

строении модели.

Затраты на сварочные работы сг. Предположим, что сварка

будет проводиться аппаратом, при использовании которого полные

расходы составляют 10 долл./ч (включая эксплуатационные расходы

п издержки на техническое обслуживание и текущий ремонт). Далее

пусть сварочный аппарат накладывает один кубический дюйм свар-

24

ГЛАВА 1 .

кого шва за 6 мин. Тогда затраты на сварочные работы равны

- _ / 1 л ДОЛЛ- W 1 Ч \ / g мин \ 17 _ 1 /долл. \ 17

. 1 \ 4 ) \60 мин ) \ дюйм3/ 'w \дюйм3/ ®”

где Vw— объем сварного шва в кубических дюймах.

Стоимость материалов с2.

Сг = С3Уш+с4УЯ,

где с3 = стоимость / объем сварного шва = (0,37)-(0,283) (долл./

/дюйм3); с4 = стоимость / объем балки = (0,17)-(0,283) (долл./

/дюйм3); Vb — объем балки А в кубических дюймах.

Из геометрических соотношений следует, что

Vu,=2(1/2/i2/)=/i2/, Vg—tb(L+l).

Имеем

c2=c3h2l+c4lb (L+l).

Следовательно, функция затрат принимает следующий вид:

F (x)=h4+c^l+c4tb (L+l), (1.11)

или (если выразить ее через переменные х)

F (х)=(1 +c3)x?x2+c4x3x4(L+x2). (1.12)

Заметим, что все комбинации значений х4, х2, х3 и х4 могут ока-

заться допустимыми, если балка выдерживает заданную нагрузку.

Необходимо построить несколько функциональных соотношений

между управляемыми переменными, позволяющих сузить область

их допустимых значений. Эти соотношения, записанные в форме

неравенств, представляют модель системы. Сначала приведем эти

неравенства, а затем интерпретируем их. Имеем

gi(x)=Tf7—т(х)>0,

g2(x)=sd—о(х)>0,

g3(x)=x4—Xi>0,

g4(x)=x2>0,

g6(x)=x3>0,

ge(x)=Pc(x)-F>0,

g, (х) =%!—0,125>0,

ge(x)=0,25—б (х)^0,

(1-13)

(1.14)

(1-15)

(1-16)

(1-17)

(1-18)

(1-19)

(1.20)

где Tj— расчетное напряжение в сварном шве при сдвиге; х(х) —

максимальное напряжение в сварном шве при сдвиге, функция х;

<jd— расчетное нормальное напряжение для материала балки;

о(х) — максимальное нормальное напряжение в балке, функция х;

Рс(х) — критическая нагрузка на балку, функция х; б (х) — вели-

чина прогиба конца балки, функция х. Для того чтобы завершить

построение модели, необходимо ввести в рассмотрение несколько

формул из теории сопротивления материалов.

МЕТОДОЛОГИЧЕСКИЕ ОСНОВЫ ОПТИМИЗАЦИИ

25

Напряжение в сварном шве ч(х). В соответствии с работой [5]

напряжение в сварном шве можно разложить на две составляющие

т' и т", где т'— первичное напряжение в плоскости поперечного

сечения сварного шва, а т"— вторичное напряжение при кручении:

При этом

M = F[L+(x2/2)],

^={4+[^]Т ’

J = 2 {о,7О7хЛ [4 + >

где М — момент силы F относительно центра тяжести сварной груп-

пы, J — полярный момент инерции сварной группы. Напряжение

т в сварном шве вычисляется в соответствии с формулой

т(х)=[(т')2+2тЧ" cos 0+(т")211/2,

где cos 0=хг/2/?.

Напряжение при изгибе балки о(х). Можно показать, что мак-

симальное напряжение при изгибе равно

a(x)=6FL/x4X3.

Критическая нагрузка на балку Рс(х). С ростом отношения tlb~

=х8/х4 наблюдается тенденция к потере устойчивости балки. Те

комбинации значений х3 и х4, при которых возможна потеря устой-

чивости, необходимо исключить из числа допустимых. В работе {6]

показано, что для балок, близких к прямоугольным, критическая

нагрузка приближенно описывается следующим выражением:

/Г.

где Е — модуль Юнга = 30X10’ фунт/дюйм2, /=(1/12) х3х4, <х =

= (1/3) Gxsx4, G — модуль сдвига = 12X10* фунт/дюйм2.

Прогиб балки б(х). Чтобы вычислить величину прогиба, пред-

положим, что балка представляет собой консоль с вылетом L. Тогда

6 (х)=(4/?£3)/(£х1х4).

Остальные неравенства интерпретируются следующим образом:

g3>0 устанавливает практическую невозможность получения свар-

ного шва, ширина которого превышает ширину балки, a g4^0 и

g5^0 отражают требования неотрицательности х2 и х8. Заметим,

что неотрицательность х4 и х4 следует из неравенств g3^0 и g-^O-

Ограничение g6^0 гарантирует, что критическая нагрузка на балку

не будет превышена. Неравенство отражает тот факт, что фи-

26

ГЛАВА 1

зически невозможно сделать сварной шов, ширина которого меньше

некоторого порогового значения.

Наконец, параметры zd и ad, фигурирующие в gr и g2, зависят

от материала конструкции. Для стали марки 1010 соответствующие

значения этих параметров равны ^=13 600 фунт/дюйм2 и od =

=30 000 фунт/дюйм2.

Оптимизационная задача проектирования включает функцию

затрат (1.12) и сложную систему неравенств, которая получается

путем подстановки приведенных выше формул в (1.13) — (1.20).

При этом все функции оказываются выраженными через четыре не-

зависимые переменные.

Данная задача достаточно сложна и, как легко видеть, не может

быть решена графическим способом. Однако оптимальный проект

нетрудно получить с помощью численных методов, рассматриваемых

в последующих главах.

Более подробное обсуждение этой задачи и методов ее решения

можно найти в [7].

1.2.2. Использование методов оптимизации

при планировании и анализе функционирования систем

Вторая важнейшая область применения оптимизационных мето-

дов в инженерной практике связана с совершенствованием суще-

ствующих систем и разработкой производственных планов для мно-

гопродуктовых технико-экономических процессов. Задачи анализа

функционирования систем обычно возникают в тех случаях, когда

требуется адаптировать существующую производственную систему

к новым условиям функционирования, отличным от тех условий,

которые были предусмотрены проектом этой системы. Причины,

порождающие требования такого рода, как правило, связаны с не-

обходимостью

1) увеличения общего объема выпуска продукции;

2) использования других видов сырья и расширения ассорти-

мента изделий;

3) совершенствования технологических операций, отличающихся

низким уровнем проектных решений.

В связи с решением указанных задач требуется выбрать новый

температурный режим, давление или характеристики потока; уста-

новить дополнительное оборудование; разработать новые техноло-

гические операции. Методы оптимизации в производственном пла-

нировании ориентированы главным образом на составление про-

грамм производства нескольких видов продукции на отдельном

предприятии, а также на координирование производственных пла-

нов предприятий, которые связаны хозяйственными отношениями.

Поскольку в таких приложениях предполагается, что основное обо-

рудование установлено и функционирует, предметом исследования

являются только функции переменных затрат. Возникающие при

МЕТОДОЛОГИЧЕСКИЕ ОСНОВЫ ОПТИМИЗАЦИИ

2/

Рис 1 5. Схема к задаче планирования нефтеперерабатывающего производства,

пример 1.3.

этом задачи чаще всего можно сформулировать с помощью линейных

и квазилинейных моделей. В качестве иллюстрации этого класса

приложений оптимизационных методов рассмотрим задачу плани-

рования производства нефтепродуктов.

Пример 1.3. Планирование производства нефтепродуктов

Описание задачи. В процессе переработки сырой нефти

производится определенное количество бензиновых полупродуктов,

которые затем последовательно смешиваются с целью получения

двух видов топлива для двигателей внутреннего сгорания — обыч-

ного топлива и топлива высшего качества. Для каждого полупро-

дукта известны значение показателя его эффективности, максима ть-

ный выход и фиксированная цена единицы объема полупродукта.

Для каждого вида топлива установлены минимальное значение

показателя эффективности и продажная цена, а также известны

удельные затраты на смешивание топлива. Минимальный уровень

производства обоих видов топлива определяется договорными обя-

зательствами. Остальное произведенное топливо и неиспользован-

ные полупродукты могут быть реализованы посредством свободной

продажи по известным ценам. Требуется составить оптимальный

план производства топлива в течение заданного периода времени.

Постановка задачи. На схеме, изображенной на

рис. 1.5, показано что исследуемая система включает ряд бензц-

28

ГЛАВА 1

новых полупродуктов, технологическую операцию смешивания и

два вида жидкого моторного топлива. Процессы переработки нефти

и производства полупродуктов исключены из рассмотрения наряду

с подсистемами управления запасами и распределения сырой нефти,

полупродуктов и конечной продукции. Поскольку оборудование,

необходимое для выполнения операции смешивания, к началу пла-

нового периода установлено и функционирует, следует рассмотреть

только стоимостные характеристики производственного процесса.

Характеристическим показателем качества функционирования

системы в данном случае является чистая прибыль, реализуемая

в течение планового периода. Чистая прибыль состоит из дохода от

продажи топлива и полупродуктов за вычетом затрат на смешивание

и производство полупродуктов. Независимые переменные выражают

величины потоков по ориентированным дугам, изображенным на

рис. 1.5. Таким образом, с каждым из полупродуктов ассоциированы

три переменные. Одна из переменных выражает количество полу-

продукта, направляемого на производство обычного топлива, вто-

рая — количество полупродукта, направляемого на производство

топлива высшего качества, и третья — количество полупродукта,

поступающего в свободную продажу.

Итак, для каждого полупродукта с номером i

xt— количество полупродукта, используемого для производства

обычного топлива,

yt— количество полупродукта, используемого для производства

топлива высшего качества,

2,-— количество полупродукта, направляемого в свободную про-

дажу.

С каждым видом производимого топлива в свою очередь ассоции-

рованы две переменные, одна из которых представляет количество

топлива, продаваемого по договорам, а другая — количество топ-

лива, поступающего в свободную продажу.

Таким образом, для каждого вида топлива с номером /

Uj— количество топлива, продаваемого по договорам,

Vj— количество топлива, поступающего в свободную продажу.

В модель следует включить балансовые соотношения для каждого

полупродукта и каждого вида топлива, ограничения, связанные

с технологической операцией смешивания и позволяющие учесть

заданные уровни эффективности двух видов топлива, а также огра-

ничения, вытекающие из наличия договорных обязательств.

1. Балансовое соотношение для полупродукта с номером i

записывается в виде неравенства

*i+y i+Zi^ctj, (1.21)

где а(-— выход полупродукта i за плановый период.

2. Балансовые соотношения для конечной продукции имеют

следующий вид:

ui + yi> = + (1-22)

МЕТОДОЛОГИЧЕСКИЕ ОСНОВЫ ОПТИМИЗАЦИИ

29-

3. Технологические ограничения, связанные с операцией сме-

шивания, записываются в виде

+ 2₽г-Уг->Т2(«2 + Уг). (1.23).

где значение показателя эффективности полупродукта i, а у,-—

минимальное значение показателя эффективности топлива вида /.

4. Ограничение, обусловленное договорными обязательствами,

для топлива вида / задается неравенством

«Z>6Z, (1.24)

где 6у— минимальный объем производства топлива вида /, преду-

смотренный договорами.

Характеристический показатель качества функционирования

системы (чистая прибыль) определяется выражением

2е/1>и/ + 2 сГи/ + 2 c™zi~ 2с<4’ (xz + Уг + —

—2 е*5’ (Xf + yt), где

i

с)11 — продажная цена единицы конечной продукции вида / в соот-

ветствии с договорами; с)2’ — рыночная цена единицы конечной

продукции вида /; с<3) — рыночная цена единицы полупродукта i;

— затраты на производство единицы полупродукта I; с<-” —

технологические затраты на смешивание в расчете на единицу полу-

продукта г.

С учетом данных, приведенных в табл. 1.1, задача планирования

принимает следующий вид:

минимизировать 40u1+55u2+46ui+60y2+ 621+82 24-7,5234-7,5021+

+2025—25 (X14-Z/1)—28 (х2+у2)—29,50 (х3+у3)—35,50 (х4+//4)—

—41,50 (х5+у5)

при следующих ограничениях:

ограничения типа (1.21):

Xi+yi+Zi^X 10\

x2+y2+z2s^4x 10\

х3+у3+г3^4х 103,

X4-\~yt~\~Zt^5X 105,

^5+ys+z5<5x 10s;

ограничения типа (1.22):

Х1+х2+х3+л:4+хв=«14-ц1,

У^У^Уз^Уь+Уь—иг+из}

ограничения типа (1.23):

70х1+80ха+85х34-90х4+99х5>85 («i+щ),

70i/1+80z/2+85z/3+90//4+99z/5>95(tz2+u2);

30

ГЛАВА I

ограничения типа (1.24):

ut^5 X 105, u2>4X10\

Таблица 1.1. Данные для примера 1.3

Номер полупродукта Выход полу- продукта а.» баррель/пе- риод Показатель эффективности Продажная цена cj.3> Затраты на производство 44) Технологиче- ские затраты г(&) i

1 2-1(Р 70 30,00 24,00 1,00

2 4. Ю> 80 35,00 27,00 1 ,00

3 4-10= 85 36,00 28,50 1,00

4 5-10’ 90 42,00 34,50 1 ,00

5 5-10’ 99 60,00 40,00 1,50

Вид топлива Минимальный объем произ- водства Максимальное значение по- казателя эф фектнвности v/ Продажная цена, долл /баррель

по ^оговорам ,(1) / рыночная -(2) /

обычное (1) 5-10' 85 40,00 46,00

высшего качест- 4.10’ 95 55,00 60,00

ва (2)

Кроме того, все переменные должны принимать неотрицательные

значения; в противном случае решение задачи может и не иметь

«физической» интерпретации. В целом задача оптимизации включает

19 переменных и 11 ограничений, а также условия неотрицательности

переменных. Заметим, что все фигурирующие в модели функции

являются линейными относительно независимых переменных.

Вообще говоря, в процессе нефтепереработки производится зна-

чительно большее количество различных полупродуктов и видов

конечной продукции, чем это предполагалось в рассмотренном

примере. Кроме того, в ряде практических ситуаций целесообразно

ввести дополнительные переменные, отражающие динамику управ-

ления запасами, а также расширить модельные построения на не-

сколько последовательных плановых периодов. В последнем случае

каждая переменная должна быть снабжена вторым индексом, на-

пример:

— количество полупродукта i, используемое для производ-

ства обычного топлива в плановом пециоде k.

МЕТОДОЛОГИЧЕСКИЕ ОСНОВЫ ОПТИМИЗАЦИИ

31

При этом размерность результирующей модели производственного

планирования существенно возрастает. На практике решение задач

такого типа с числом переменных, превышающим тысячу, осуще-

ствляется на основе специальных алгоритмов.

1.2.3. Использование методов оптимизации для анализа

и обработки информации

Еще одна широкая область применения оптимизационных мето-

дов в инженерной практике связана с задачами инженерного анали-

за, в частности с задачами нелинейного регрессионного анализа.

Среди наиболее общих проблем, возникающих в процессе разработки

инженерных моделей, можно выделить проблему определения пара-

метров некоторой полуэмпирической модели на основе заданного

множества экспериментальных данных. Такого рода задачи обра-

ботки информации, или задачи регрессионного анализа, путем не-

сложных преобразований приводятся к виду оптимизационных за-

дач, поскольку выбор значений параметров модели осуществляется

в соответствии с критерием качества описания имеющихся данных

с помощью этой модели.

Предположим, что некоторая переменная у зависит от некоторой

независимой переменной х, а связь между ними задается уравне-

нием y=f (х, 01, 02), в котором фигурируют два параметра (Д и 02.

Для того чтобы определить соответствующие значения 0j и 02,

необходимо провести серию экспериментов, в каждом из которых

задается значение независимой переменной х и регистрируется зна-

чение зависимой переменной у. Результатом серии из N экспери-

ментов является множество пар чисел (yt, х{), i = l.N. Затем

на основе полученной информации делается попытка подобрать зна-

чения и 02 таким образом, чтобы обеспечить хорошую точность

описания экспериментальных данных с помощью функции f. Наибо-

лее часто используемая на практике мера качества описания экспе-

риментальных данных определяется так называемым критерием

наименьших квадратов, в соответствии с которым требуется мини-

мизировать функцию

/V

^(0п ег)= 2 kT-Ж.. е„ е2)р. (1.25)

i= 1

Разность yt—f(xh 0Ь 02) между зарегистрированным значением

у{ и теоретическим значением f(xh 6Х, 02) показывает, насколько

точно выбранная модель описывает имеющиеся данные, и называ-

ется остатком. Сумма квадратов остатков по всем эксперименталь-

ным точкам является мерой точности описания данных. Действи-

тельно, если значение L(Qit 02) равно нулю, то сделанный выбор

0! и 02 обеспечивает точное описание, поскольку экспериментальные

данные совпадают с теоретической кривой. Таким образом, задачу

32

ГЛАВА 1

описания данных можно рассматривать как задачу оптимизации,

в которой требуется найти значения параметров 61 и 62, минимизи-

рующие функцию L(9i, 62).

Пример 1.4. Нелинейная регрессия

Описание задачи. Известно, что соотношение между

давлением, молярным объемом и температурой реальных газов отли-

чается от аналогичного соотношения для идеального газа, которое

записывается в виде

(1.26)

Pv=R Т,

где Р— давление (атм), v — молярный объем (см8/г-моль); Т —

температура (К), R — универсальная газовая постоянная

(82,06 атм-см3/г-моль-К).

Полуэмпирическое уравнение Редлиха — Куонга [3]

р____________________ RT________а_____

— и — Ь Tlliv(v + b)

ориентировано на то, чтобы скомпенсировать отклонение свойств

реального газа от свойств идеального газа, и содержит параметры

а и Ь, значения которых определяются на основе экспериментальных

данных. В табл. 1.2 приведены результаты измерений давления,

Таблица 1.2. Результаты измерений давления, молярного объема

и температуры углекислого газа

Номер эксперимента Р, атм и, см3/г«моль т, к

1 33 500 273

2 43 500 323

3 45 600 373

4 26 700 273

5 37 600 323

6 39 700 373

7 38 400 273

8 63,6 400 373

молярного объема и температуры углекислого газа (СО2), которые

используются при расчете нелинейной регрессии для оценивания

значений а и Ь.

Постановка задачи. Значения параметров а и b

находятся путем минимизации суммы квадратов остатков (1.25).

В данном случае эта функция имеет следующий вид:

_ RTi ।_______а 12

vi~b T^Vi(vt+b) J ’

(1-27)

МЕТОДОЛОГИЧЕСКИЕ ОСНОВЫ ОПТИМИЗАЦИИ

33

где Р(— результат измерения давления в эксперименте с номером

i, а остальные два слагаемых в скобках представляют соответствую-

щие члены уравнения (1.26) в условиях эксперимента с номером i

и зависят от параметров а и Ь. Например, слагаемое суммы, которое

соответствует первому эксперименту, равно

/по 82,06 (273) а \а

500 — 6 "г (273) V2(500; (500 + &J '

Функция (1.27) представляет собой функцию двух переменных,

которая подлежит минимизации путем соответствующего выбора

значений независимых переменных а и Ь. Если бы уравнение Ред-

лиха — Куонга точно описывало имеющиеся данные, то минималь-

ное значение функции (1.27) равнялось бы нулю. Однако наличие

экспериментальных ошибок в результатах измерений, а также от-

дельные упрощения, принимаемые при построении уравнения, при-

водят к тому, что изучаемая модель лишь приближенно описывает

свойства углекислого газа, и, следовательно, функция (1.27) не

обращается в нуль в точке оптимума. В частности, оптимальным

значениям а=6,377 • 10’ и Ь—29,7 соответствует сумма квадратов

остатков, равная 9,7» 10"2.

Кроме задач регрессионного анализа в инженерной практике

возникает множество других задач, которые можно формулировать

и решать как задачи оптимизации. Отметим ставший классическим

подход к определению равновесного состава химической смеси [3].

Известно, что равновесным состоянием замкнутой системы, началь-

ное состояние которой задано, при фиксированной температуре и

фиксированном давлении является такое состояние, при котором

свободная энергия Гиббса принимает минимальное значение. В ра-

боте [8] показано, что задача определения равновесного состава

смеси может быть сформулирована как задача минимизации нели-

нейной функции при ограничениях, образованных системой линей-

ных уравнений вместе с условиями неотрицательности переменных.

Другая классическая инженерная задача, которую можно сфор-

мулировать и решить как задачу оптимизации, связана с определе-

нием величин установившихся токов в электрической цепи, состав-

ленной из активных сопротивлений [9]. Если известны величины

сопротивлений и полный ток в цепи, то значения токов через сопро-

тивления можно определить путем решения задачи минимизации

полной потери мощности в цепи (72/?) с учетом линейных ограниче-

ний, которые обеспечивают выполнение закона Кирхгофа для каж-

дого узла цепи.

1.3. Структура оптимизационных задач

Несмотря на то что прикладные задачи, рассмотренные в преды-

дущем разделе, относятся к совершенно разным областям инженер-

ной практики и представляют различные системы, они имеют общую

2 № 1826

34

ГЛАВА I

форму. Все эти задачи можно классифицировать как задачи мини-

мизации вещественнозначной функции f (х) А'-мерного векторного

аргумента .х=(х1, х2, . . , xN), компоненты которого удовлетворяют

системе уравнений hk(x)=6, набору неравенств а также

ограничены сверху и снизу, т. е. х)и’ ^х^х^. В последующем

изложении функцию /(х) будем называть целевой функцией, урав-

нения /rfc(x)=0 — ограничениями в виде равенств, а неравенства

gy(x)^0 — ограничениями в виде неравенств. При этом предпола-

гается, что все фигурирующие в задаче функции являются веще-

ственнозначными, а число ограничений конечно.

Задача общего вида:

минимизировать /(х)

при ограничениях

(х) = 0, 1, , К,

gj^x^Q, j = \..........J,

х\Е7> Аэ х{ x-L>, i = 1, ..., N

называется задачей оптимизации с ограничениями или задачей

условной оптимизации. В частности, в примерах 1.1, 1.2 и 1.3 рас-

смотрены задачи условной оптимизации. Задача, в которой нет огра-

ничений, т. е.

J = K = 0и

х)77’ = — x-L> = оо, i = 1, ..., N,

называется оптимизационной задачей без ограничений или задачей

безусловной оптимизации. В примере 1.4 представлена задача без

ограничений.

Задачи оптимизации можно классифицировать в соответствии

с видом функций /, hk, gj и размерностью вектора х. Задачи без

ограничений, в которых х представляет собой одномерный вектор,

называются задачами с одной переменной и составляют простейший,

но вместе с тем весьма важный подкласс оптимизационных задач.

Задачи условной оптимизации, в которых функции Лли g}- являются

линейными, носят название задач с линейными ограничениями.

В таких задачах целевые функции могут быть либо линейными,

либо нелинейными. Задачи, которые содержат только линейные

функции вектора непрерывных переменных х, называются задачами

линейного программирования; в задачах целочисленного программиро-

вания компоненты вектора х должны принимать только целые зна-

чения. Одна из задач линейного программирования рассмотрена

в примере 1.3 (разд. 1.2).

Задачи с нелинейной целевой функцией и линейными ограниче-

ниями иногда называют задачами нелинейного программирования

с линейными ограничениями. Оптимизационные задачи такого рода

можно классифицировать на основе структурных особенностей не-

линейных целевых функций. Если /(х) — квадратичная функция,

то мы имеем дело с задачей квадратичного программирования; если

МЕТОДОЛОГИЧЕСКИЕ ОСНОВЫ ОПТИМИЗАЦИИ 35

f(x) есть отношение линейных функций, то соответствующая задача

носит название задачи дробно-линейного программирования, и т. д.

Деление оптимизационных задач на эти классы представляет зна-

чительный интерес, поскольку специфические особенности тех или

иных задач играют важную роль при разработке методов их реше-

ния. В последующих главах рассматриваются методы, которые

можно использовать для решения таких задач.

1.4. Некоторые замечания о книге

в целом

В книге изложены методологические основы анализа задач как

условной, так и безусловной оптимизации. Главное внимание здесь

уделено общим методам, которые применимы к решению задач с

непрерывными переменными, действительными функциями, вхо-

дящими в ограничения, и единственной действительной целевой

функцией. Задачи, включающие целочисленные или дискретные

переменные, рассмотрены лишь кратко. Кроме того, исключены

оптимизационные задачи, содержащие функциональные уравнения

и структурные элементы стохастической природы, а также модели

с переменной структурой. Этот материал представляет значительный

интерес, однако является весьма сложным и поэтому должен быть

освещен в специальных работах. Авторы стремились к изложению на

достаточно высоком уровне математической строгости; вместе с тем

подробные доказательства математических результатов в тексте

отсутствуют, за исключением тех случаев, когда они служат для

разъяснения приемов построения алгоритмических структур. До-

казательства используемых результатов можно найти, руковод-

ствуясь ссылками на литературные источники. Важно подчеркнуть,

что изложение материала книги ориентировано в первую очередь

на построение и пояснение системы понятий, лежащих в основе

изучаемых математических конструкций.

Одна из целей написания данной книги заключается в том, чтобы

продемонстрировать возможности применения методов оптимизации

к решению инженерных задач. В связи с этим значительная часть

материала посвящена рассмотрению конкретных примеров из ин-

женерной практики, обсуждению вариантов постановок задач и

анализу вычислительных методов, которые облегчают решение

прикладных задач. Кроме того, особое внимание уделено вопросам

эффективности вычислений, тесно связанным с проблемой выбора и

использования тех или иных методов при определенных условиях.

В гл. 2 исследуется простейшая задача оптимизации, а именно

задача безусловной оптимизации с одной переменной. Полученные

результаты затем обобщаются на случай многомерной задачи безу-

словной оптимизации. В гл. 4 анализируются задачи и методы ли-

нейного программирования. Гл. 5 посвящена исследованию нели-

2*

36

ГЛАВА 1

нейных задач с ограничениями и анализу условий оптимальности

для этих задач. В гл. 6—10 излагаются методы решения задач с огра-

ничениями. Гл. 6 знакомит с методами преобразования задач услов-

ной оптимизации в задачи без ограничений, гл. 7 — с методами пря-

мого поиска. В гл. 8 и 9 рассматривается важный класс методов,

использующих процедуру линеаризации. В гл. 10 исследуются

методы, основанные на квадратичной аппроксимации. Методы, ис-

пользуемые при решении задач со специальной структурой, описы-

ваются в гл. 11. Далее, в гл. 12, приводятся результаты сравнитель-

ного анализа методов оптимизации с точки зрения эффективности

вычислений. Книга завершается обзором методических рекоменда-

ций по проведению оптимизационных исследований (гл. 13) и под-

робным обсуждением трех конкретных примеров из инженерной

практики (гл. 14).

Литература

1. Zeleny М., Multiple Criteria Decision Making, McGraw-Hill, N.Y., 1982.

2. Vincent T. L., Grantham W.J., Optimality in Parametric Systems, Wiley, N.Y.,

1981.

3. Bett K.E., Rowlinson J.S., Saville G., Thermodynamics for Chem cal Engineers,

MIT Press, Cambridge, Massachusetts, 1975.

4. Jen F. C , Pegels С. C., Dupuis T. M., Optimal Capacities of Production Facili-

ties, Management Sci., 14B, 570—580 (1968).

5. Shigley J E., Mechanical Engineering Design, McGraw-Hill, N. Y., 1973, p. 271.

6. Timoshenko S., Gere J., Theory of Elastic Stability, McGraw-Hill, N.Y., 1961,

p. 257.

7. Ragsdeil К. M., Phillips D. T., Optimal Design of a Class of Welded Structures

using Geometric Programming, ASME J. Eng. Ind. Ser. В , 98, (3), 1021—1025

(1975).

8. White W. B., Johnson S. M., Dantzig G. B., Chemical Equilibrium in Complex

Mixtures, J. Chem Phys , 28, 251—255 (1959).

9 Hayt W. H., Kemmerly J. E., Engineering Circuit Analysis, McGraw-Hill, N. Y.,

1971. Ch. 2.

Глава 2

Функции одной переменной

Задача оптимизации, в которой характеристическая мера задана

функцией одной переменной, относится к наиболее простому типу

оптимизационных задач. Тем не менее анализ задач такого типа

занимает центральное место в оптимизационных исследованиях как

теоретической, так и практической направленности. Это связано не

только с тем, что именно такие задачи обычно решаются в инженер-

ной практике, но и с тем, что одномерные методы оптимизации часто

используются для анализа подзадач, которые возникают при реа-

лизации итеративных процедур, ориентированных на решение мно-

гомерных задач оптимизации. Важность теоретических и приклад-

ных оптимизационных задач с одной управляемой переменной

обусловила разработку большого числа алгоритмов их решения.

Классификация методов решения одномерных задач по существу

основывается на различных предположениях и допущениях отно-

сительно природы и свойств функции f(x).

2.1. Свойства функций одной переменной

Согласно наиболее простому определению, функция [ (х) пред-

ставляет собой правило, которое позволяет каждому значению х

поставить в соответствие единственное значение y=f(x). В этом

случае х носит название независимой переменной, ay — зависимой

переменной. Рассмотрим множество Sc.R, где R — множество всех

действительных чисел. Мы можем определить соответствие (или

преобразование), с помощью которого каждой точке x£S приписы-

вается единственное числовое значение. Такое соответствие назы-

вается скалярной функцией f, определенной на множестве S.

Когда множество S=R, мы имеем дело со всюду определенной

функцией одной переменной. Если S есть некоторое подмножество

множества R, то функция f определена в ограниченной области.

Например,

/(х)=х3+2х2—х+З для всех x£R

38

ГЛАВА 2

есть всюду определенная функция, тогда как функция

f(x)=xs+2x2—х—3 для всех х € S= {х|—5^х<5}

определена в ограниченной области. В теории оптимизации f назы-

вается целевой функцией, aS— допустимой областью, множеством

точек, удовлетворяющих ограничениям, или областью допустимых

значений х.

Ряд физических процессов можно описать (или построить моде-

ли этих процессов) с помощью непрерывных функций, т. е. функций,

которые обладают свойством непрерывности в каждой точке х,