Текст

Э. СЕЙДЖ, ДЖ. МЕЛС

Теория оценивания

и ее применение

в связи

и управлении

Перевод с английского

под редакцией проф. Б. Р. Левина

Выпуск 6

ИЗДАТЕЛЬСТВО «СВЯЗЬ*

МОСКВА 1976

6Ф0.1

С28

УДК 621.39: 519.25(075.8)

Редакционная коллегия:

Б. Р. ЛЕВИН (ответственный редактор серии), А. Г. ЗЮКО,

Е. Н. САЛЬНИКОВ, Л. М. ФИНК, Б. С. ЦЫБАКОВ, В. В. ШАХ-

ГИЛЬДЯН, Ю. С. ШИНАКОВ.

Сейдж Э., Меле Дж.

С28 Теория оценивания и ее применение в связи и управ-

лении. Пер с англ, под ред. проф. Б. Р. Левина. М,

«Связь», 1976.

496 с. с ил., табл. (Статистическая теория связи, вып. 6).

Книга посвящена теории оптимальной линейной н нелинейной фильтра-

ции сигналов и приложениям этой теории к задачам связи н управления

Кинга не требует от читателя специальной математической подготовки. Она

отличается высокими методическими качествами изложения н обилием фак-

тического материала, не содержащегося в аналогичных монографиях

Книга рассчитана на научных работников, аспирантов н студентов стар-

ших курсов Она будет полезна широкому кругу инженеров

30401 — 125

С ------------ 10—76

045(01)—76

6Ф0.1

А. Р. S a g е and J. L. М е 1 s е. Estimation Theory with Ap-

plication to Communication and Control. N.-Y.

McGraw-Hill, 1972.

© Перевод на русский язык. Издательство «Связь», 1976 г.

ПРЕДИСЛОВИЕ РЕДАКТОРА ПЕРЕВОДА

Представляемая книга относится к области теории оце-

нивания. Но основное внимание авторы книги уделяют система-

тическому изложению вопросов фильтрации, экстраполяции и

интерполяции случайных сигналов на фоне случайных помех.

Хотя в Советском Союзе и за рубежом издано немало моногра-

фий, посвященных этим вопросам, некоторые особенности книги

Сейджа и Мелса побудили нас включить ее перевод в серию

«Статистическая теория связи». Это, во-первых, высокие методи-

ческие качества изложения и обилие фактического материала, не

содержащегося в аналогичных 'монографиях, по крайней мере, на

русском языке. Далее, как подчеркивают авторы в предисловии,

книга написана инженерами для инженеров и поэтому не требует

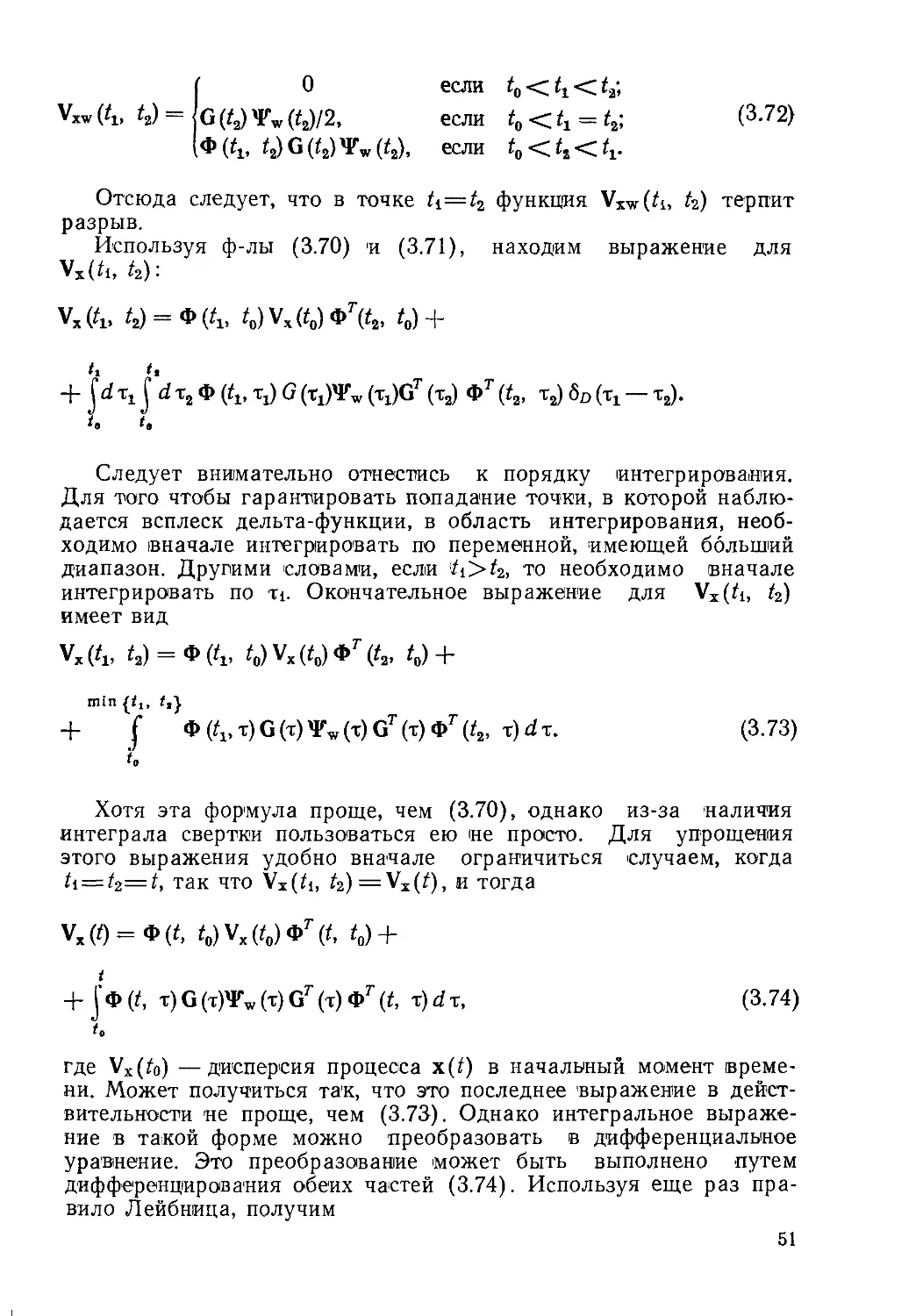

от читателя специальной математической подготовки. Для освое-

ния представленного материала необходимы прочное знание ву-

зовских курсов теории вероятностей и математической статистики

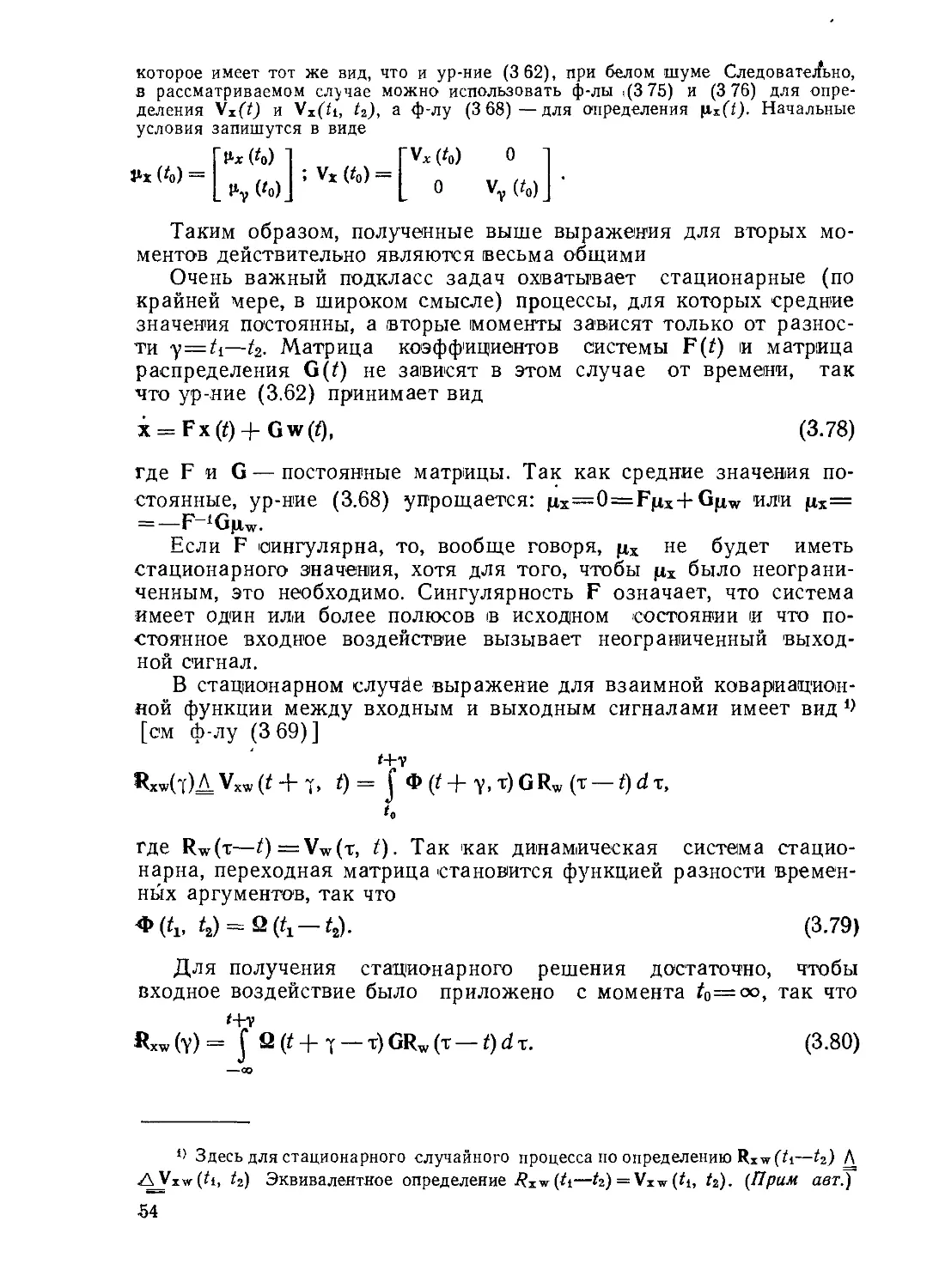

и, конечно, терпение при анализе довольно громоздких .алгорит-

мов, а также настойчивое повторение, если понимание не прихо-

дит сразу. Наконец, для практического использования в задачах

связи и управления читатель получает детально разработанные

(и сведенные в таблицы) алгоритмы линейной и нелинейной

фильтрации (а также экстраполяции и интерполяции) сигналов

на фоне белых и небелых шумов в непрерывном и дискретном

(для реализации на ЦВМ) вариантах.

Первая половина книги искусно подготавливает необходимый

математический аппарат, но хорошо подготовленному читателю

следует познакомиться с этой частью книги лишь для освоения

часто необычных обозначений и терминов, используемых автора-

ми. Редактор не решился на изменения многих обозначений и не-

скольких терминов, хотя по ряду причин некоторые замены оказа-

лись неизбежными. Следует, например, иметь в виду, что случай-

ный (полезный) сигнал представляется авторами как исходное

сообщение (детерминированное), искаженное шумами. Кроме

того, шумы возникают и при наблюдении (измерении). Неологизм

«innovation process» переведен здесь как «обновляющий процесс»

(ранее в работе [300*] использовался термин «порождающий

процесс»). Было признано целесообразным в некоторых местах

сократить оригинальный текст, особенно за счет длиннот и повто-

рений 1>.

Перевод выполнили Е. Б. Левина (гл. 1—3), Ю. С. Шинаков

(гл. 4—6), В. И. Журавлев (гл. 7 и первая половина гл. 8),

С. Д. Свет (вторая половина гл. 8 и гл. 9).

Проф. Б. Р. Левин

По предложению издательства в перевод не включены задачи для само-

стоятельного решения, которые содержатся в оригинале.

3

ПРЕДИСЛОВИЕ К РУССКОМУ ИЗДАНИЮ

( —.......................................—----------—

Для меня весьма приятной оказалась возможность дать

несколько кратких комментариев к русскому изданию «Теории

оценивания и ее применениям в связи и управлении». Летом

1975 года в течение чуть больше двух недель я находился в Со-

ветском Союзе В этот период я посетил несколько советских

городов, встречался со многими советскими учеными и обсуждал

с ними научные вопросы, представляющие взаимный интерес.

После такого путешествия особенно волнующим оказалось для

меня известие о том, что книга, которую написали мы с доктором

Сэйджем, станет более доступной советским ученым благодаря

ее переводу на русский язык

Эта книга была задумана как попытка собрать воедино и в

одинаковых обозначениях огромное количество результатов ис-

следований, которые были посвящены такой широкой теме, как

теория оценивания с особым упором на методы последователь-

ного оценивания и их приложение к связи и управлению В двух

или трех местах приведены несколько способов получения резуль-

татов, с тем чтобы показать различные пути подхода к частному

алгоритму и его использованию Мы считаем, что такой подход

будет особенно полезен изучающим теорию, и мы уже получили

положительные отзывы относительно такой методологии. Боль-

шинство алгоритмов, для облегчения ссылок на них, сведены в

таблицы.

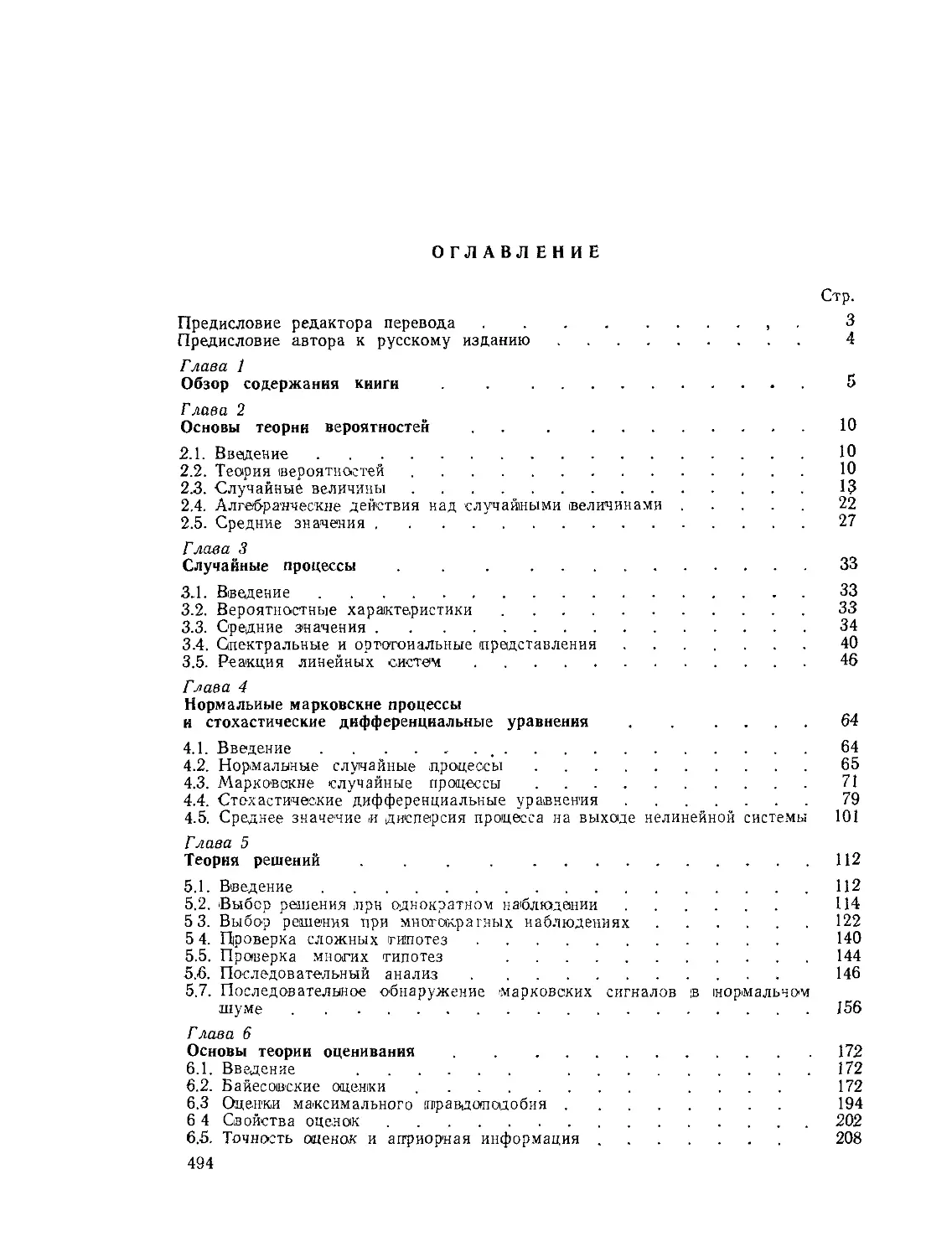

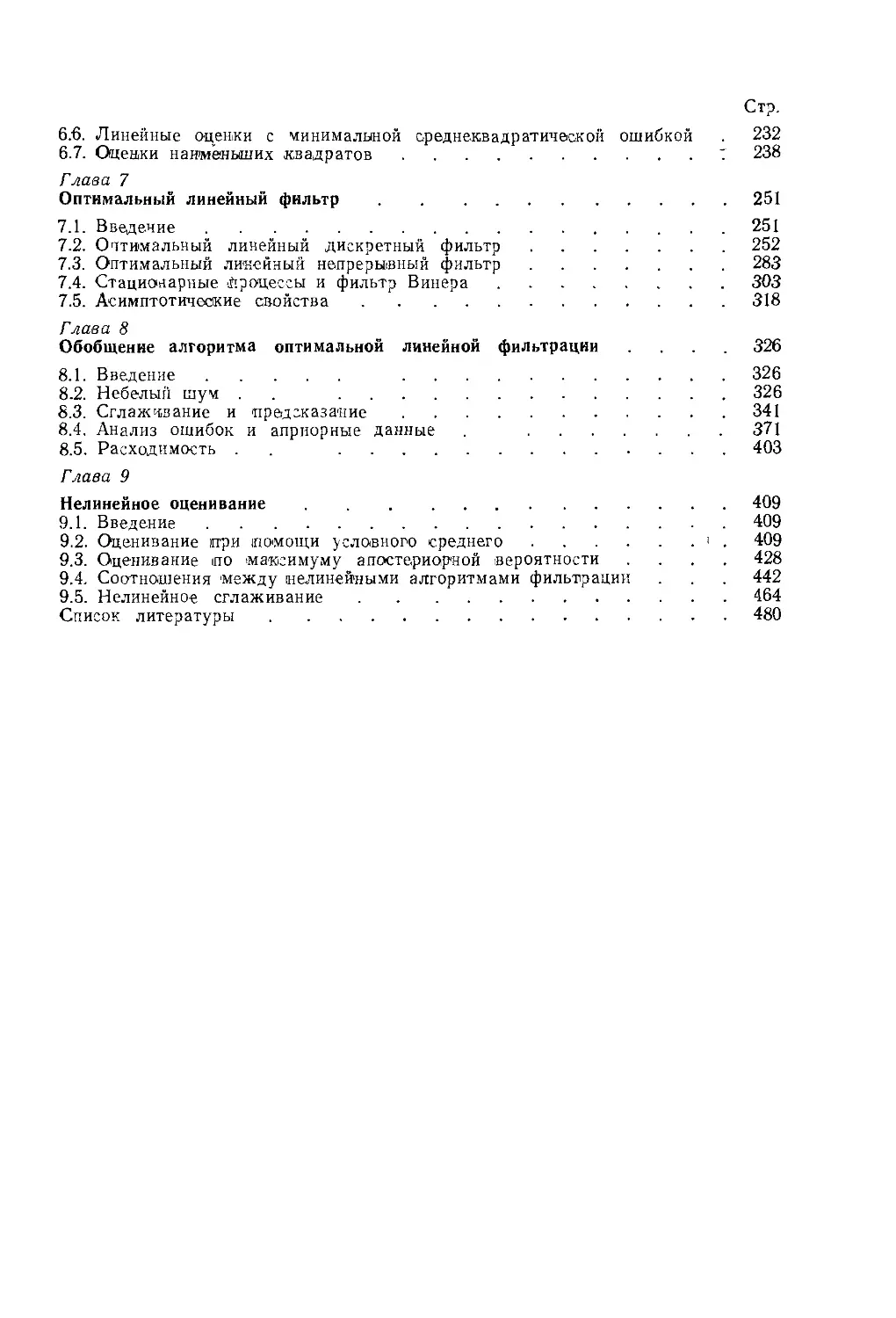

Книга может быть разбита на три основные части. В главах

2, 3 и 4 приведен обзор теории случайных величин и случайных

процессов, детально рассмотрено общее представление марков-

ских процессов в виде динамической системы и, в частности, нор-

мальных марковских процессов В главах 5 и 6 излагаются осно-

вы теории обнаружения и параметрической теории оценивания.

В главах 7 и 8, составляющих основную часть этой книги, при-

водится полное изложение теории линейного фильтра Калмана —

Бьюси в его различных видах Глава 9 представляет собой введе-

ние в теорию нелинейной фильтрации Отличительной особен-

ностью этой главы является подробный вывод некоторых прибли-

женных алгоритмов фильтрации по критериям условного среднего

и максимального правдоподобия и сравнение этих алгоритмов

Джеймс Л Меле

Университет Нотр Дам

Индиана, 1975 г

Глава 1

ОБЗОР СОДЕРЖАНИЯ книги

Одна из основных задач, с которой приходится сталки-

ваться инженерам (а также и большей части человечества), за-

ключается в том, чтобы наилучшим образом извлечь из наблю-

дений данные, необходимые для принятия решения. В этой книге

изложены математические процедуры нахождения оптимальных

решений в условиях, когда на эти решения оказывают влияние

все имеющиеся в наличии данные. Эту процедуру мы называем

оцениванием. Последнее, по существу, связано с понятием инфор-

мация, которое мы определим как совокупность сведений, полу-

ченных в результате принятия решения

Задача оценивания далеко не нова и относится, по крайней

мере, к временам Лежандра [135] и Гаусса [75]. Гауссу приписы-

вают первое употребление понятия оценивания (в приложении

к расчету орбит) на основе его высказывания о том, что наиболее

вероятным значением оцениваемого параметра является такое,

при котором минимизируется сумма квадратов разностей между

действительно наблюдаемыми и вычисленными значениями, умно-

женная на весовой коэффициент, отражающий относительное до-

верие к наблюдениям Это принцип минимальной среднеквадра-

тичной оценки, который будет подробно обсуждаться в гл 6 и 9.

Будем рассматривать теорию оценивания в приложении ко

многим различным областям Так, в теории связи чаще всего оп-

ределяют характеристики передаваемых сообщений по информа-

ции, извлеченной из принимаемых сигналов, которые представ-

ляют собой искаженные шумом модулированные передаваемые

сообщения Теория управления используется при разработке

автоматических систем, которые управляют установками на осно-

вании наблюдений за окружающей средой (или за действиями

противника) При исследовании операций или техническом проек-

тировании решаются задачи распределения ресурсов, товарного

учета, программирования и т. и

Для использования методов теории оценивания в конкретной

инженерной задаче эта задача должна быть сформулирована ма-

тематически на языке теории вероятностей и случайных процес-

сов После изложения основных положений этих теорий рассмот-

рим методы теории оценивания и их приложения к задачам связи

и управления. В заключение будут приведены эффективные алго-

ритмы решения упомянутых задач. Материал в книге распределен

по главам следующим образом.

5

Глава 2. Основы теории вероятностей. Теория вероятностей

изучает усредненные характеристики эмпирических событий. Эти

характеристики образуют совокупность утверждений, имеющих

различную степень уверенности относительно их справедливости.

Хотя и предполагается, что читатель имеет предварительное

представление о вероятности, в гл. 2 дается краткий обзор основ-

ных положений теории вероятностей. Основное внимание уделяет-

ся усреднению, поскольку (как будет показано) средние от функ-

ции случайных величин постоянно используются при определении

оптимальных оценок Подчеркивается различие между априорны-

ми и апостериорными (или условными) плотностями вероят-

ностей

Глава 3. Случайные процессы. Здесь рассматриваются случай-

ные процессы, являющиеся функциями времени. Вводятся такие

важные понятия, как корреляция и ковариация, которые являют-

ся мерой временной связи случайных процессов Наконец, значи-

тельное внимание уделено реакции линейных непрерывных и

дискретных систем на входной сигнал, представляющий собой

случайный процесс.

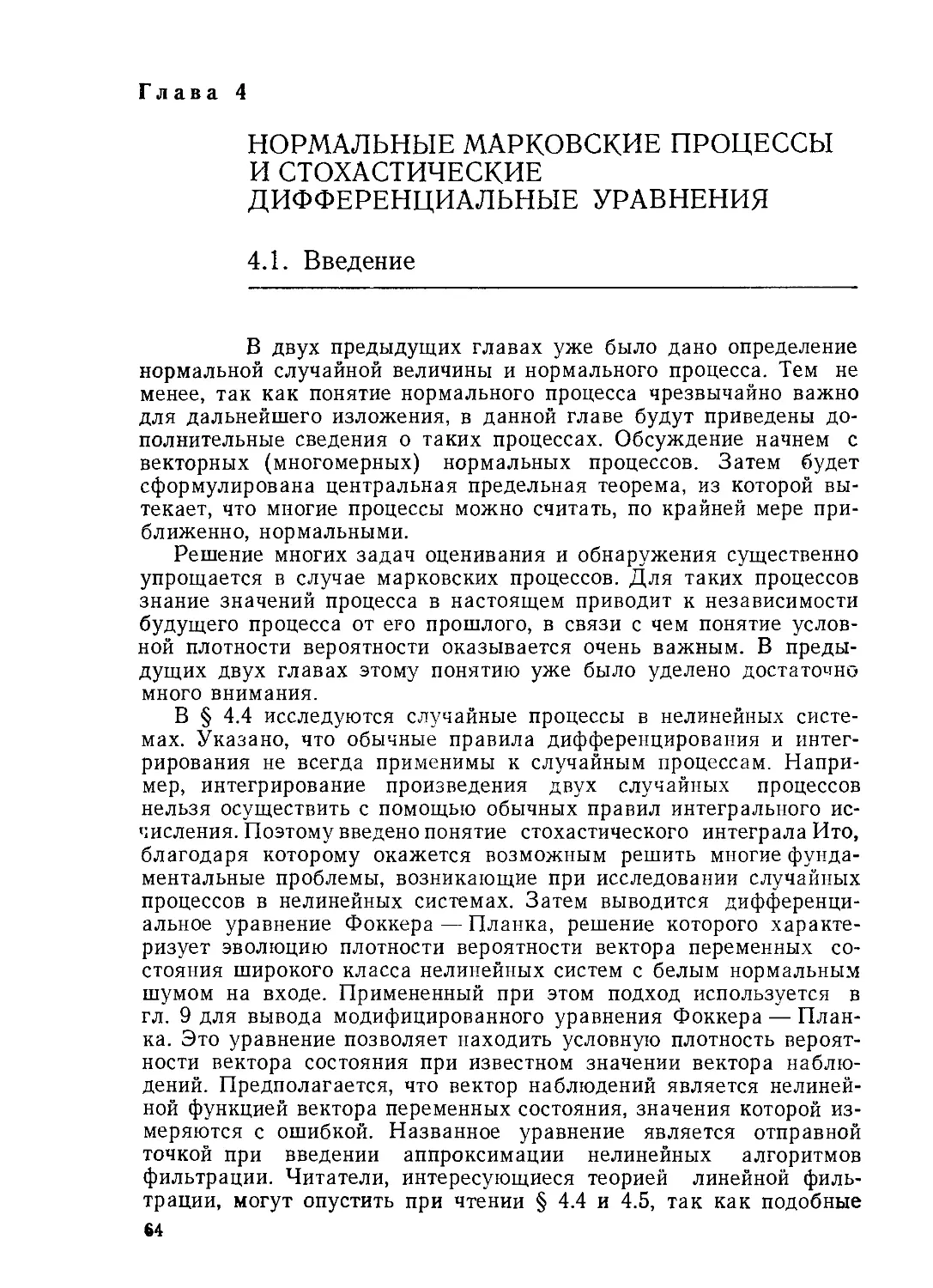

Глава 4. Нормальные марковские процессы и стохастические

дифференциальные уравнения. Разработка эффективных алгорит-

мов оценивания часто бывает возможна только в тех случаях,

когда статистика нормальная. Вследствие того, что процессы с

нормальным распределением в дальнейшем изложении будут

играть весьма важную роль, в гл. 4 дается детальное рассмотре-

ние нормальных процессов. Приводится центральная предельная

теорема, использование которой позволяет (к счастью) аппрокси-

мировать нормальным процессом многие случайные процессы.

Допущение марковости, означающее, что знание настоящего

отделяет прошедшее от будущего, также справедливо для широ-

кого класса задач и будет использовано в дальнейшем изложе-

нии. Эго допущение придает особую важность понятию условного

среднего, введенному в гл 2 Сначала более детально рассматри-

ваются нормальные марковские процессы в линейных системах.

При исследовании нелинейных систем выявляется, что обычные

правила дифференциального и интегрального исчисления не

всегда применимы Рассматривается стохастическое исчисление

Ито, позволяющее решать многие фундаментальные задачи,

включающие в себя преобразования случайных процессов в не-

линейных системах Решение уравнения Фоккера — Планка в

частных производных и его приближенное решение дают возмож-

ность получить закон изменения среднего и дисперсии в непрерыв-

ных нелинейных системах Использование теоремы об условном

среднем для нормальных случайных процессов позволяет найти

среднее и дисперсию процессов в дискретных нелинейных систе-

мах

Глава 5. Теория решений. Часто теорию решений считают от-

личной от теории оценивания и эти два предмета рассматривают-

ся как два основных раздела в статистике. Здесь, напротив, упор

6

делается на сходство теорий оценивания и обнаружения. До гл. 4

включительно в основном рассматриваются случайные сигналы и

их прохождение через линейные и нелинейные системы. В гл. 5

рассматривается вопрос: присутствует ли сигнал в смеси с шу-

мом?

Возможно, наиболее важной областью приложения теории ре-

шений является оптимальное обнаружение сигналов на фоне по-

мех и шумов. Задаваясь величиной потерь, связанных с принятием

различных решений, можно определить порог, с которым над-

лежит сравнивать наблюдения. В главе рассматриваются как де-

терминированные, так и случайные сигналы в шуме, двоичные и

М-ичные процессы принятия решения, а также проверки гипотез

при фиксированном размере выборки и при последовательном

анализе. Наконец, задача теории решений формулируется в тер-

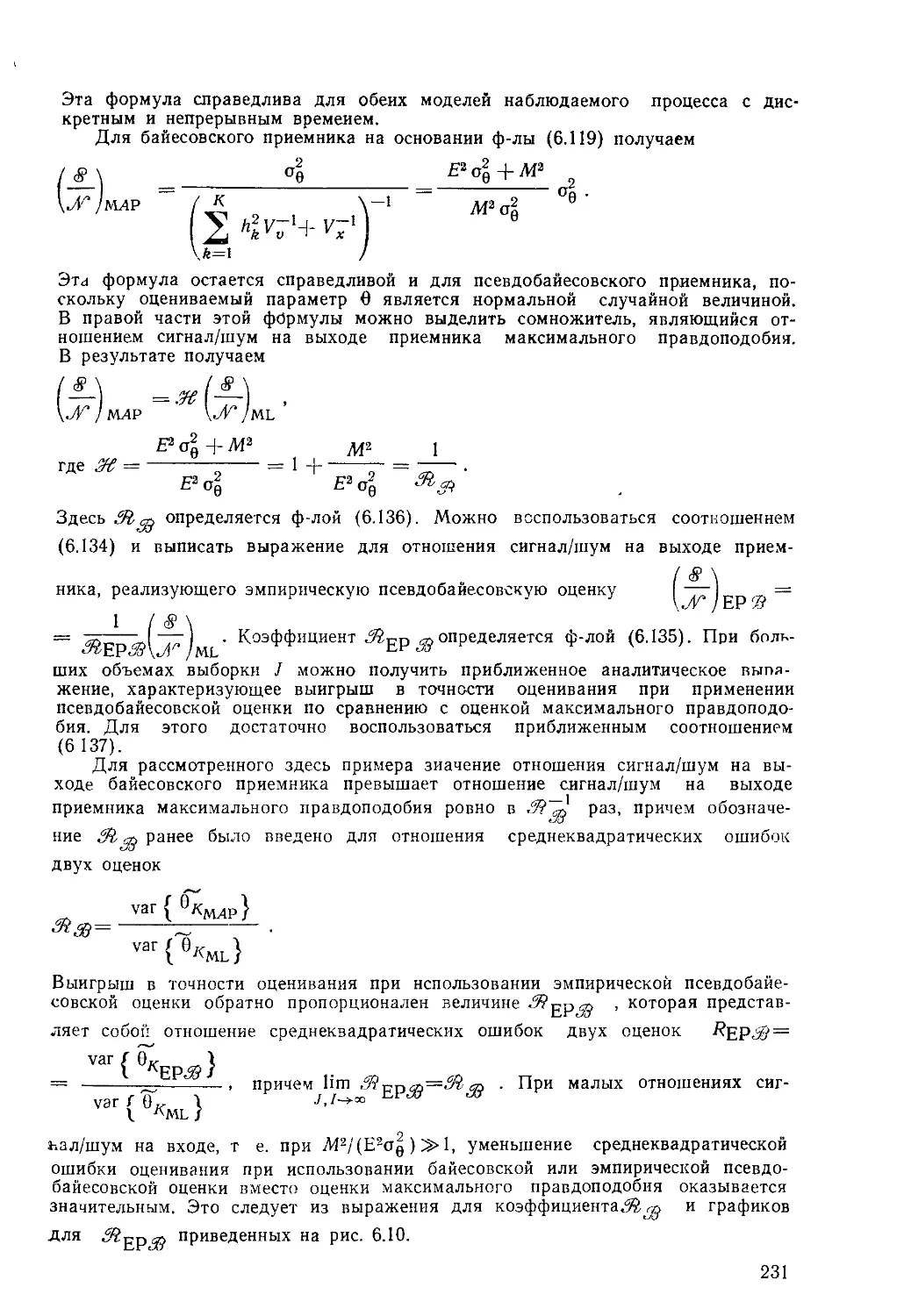

минах переменных состояния, что дает возможность установить

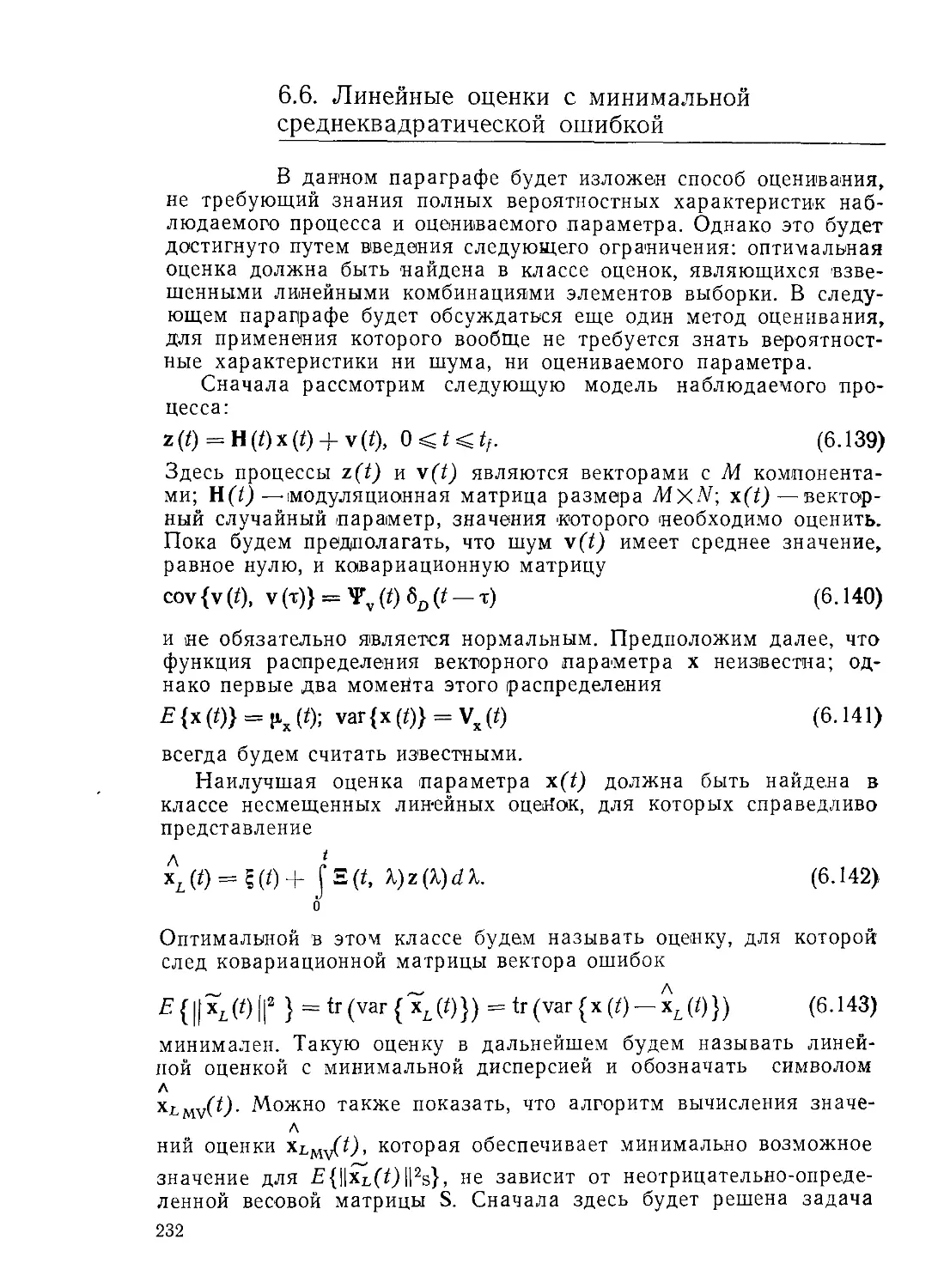

связь между теорией решений и теорией оценивания.

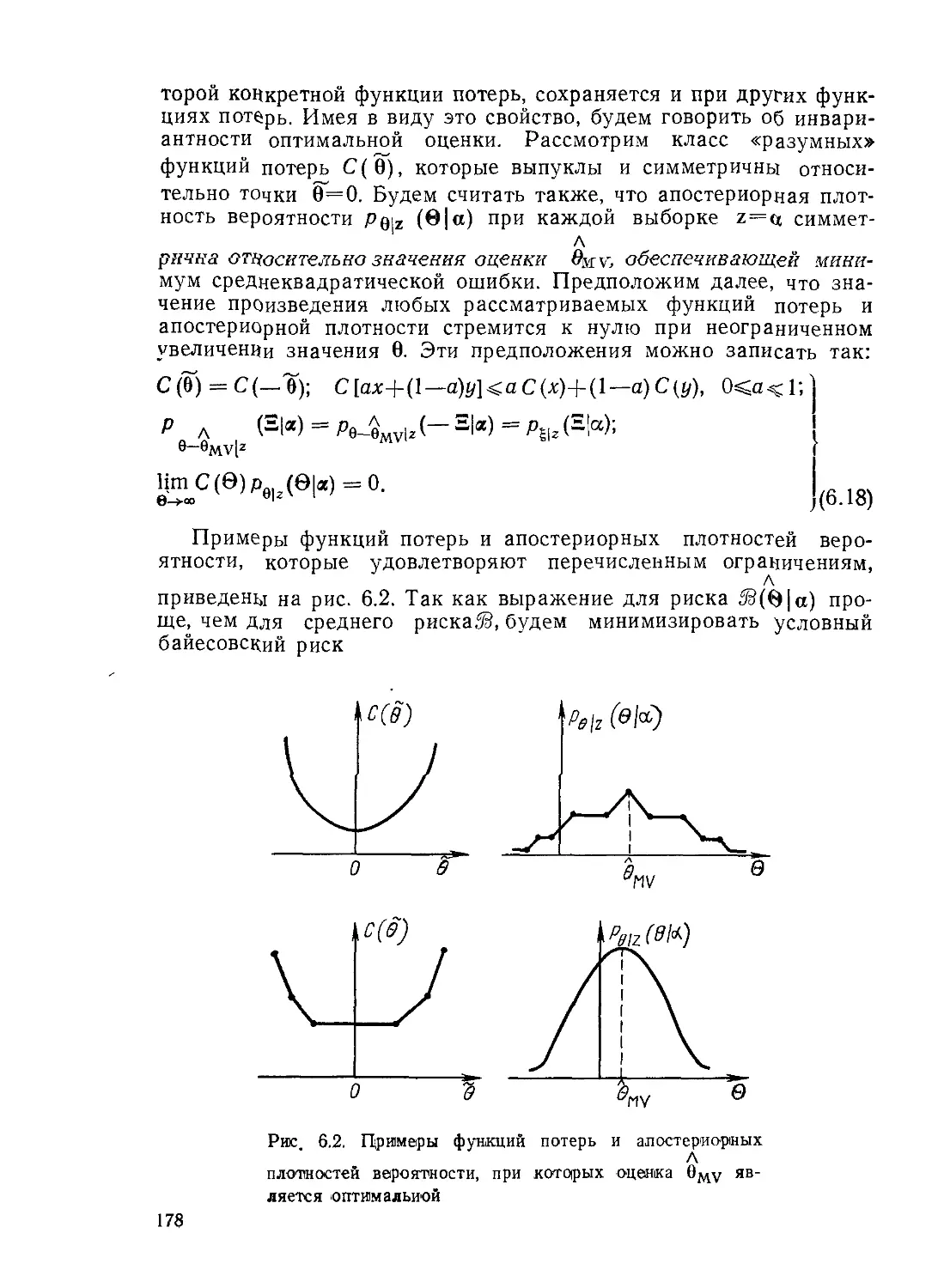

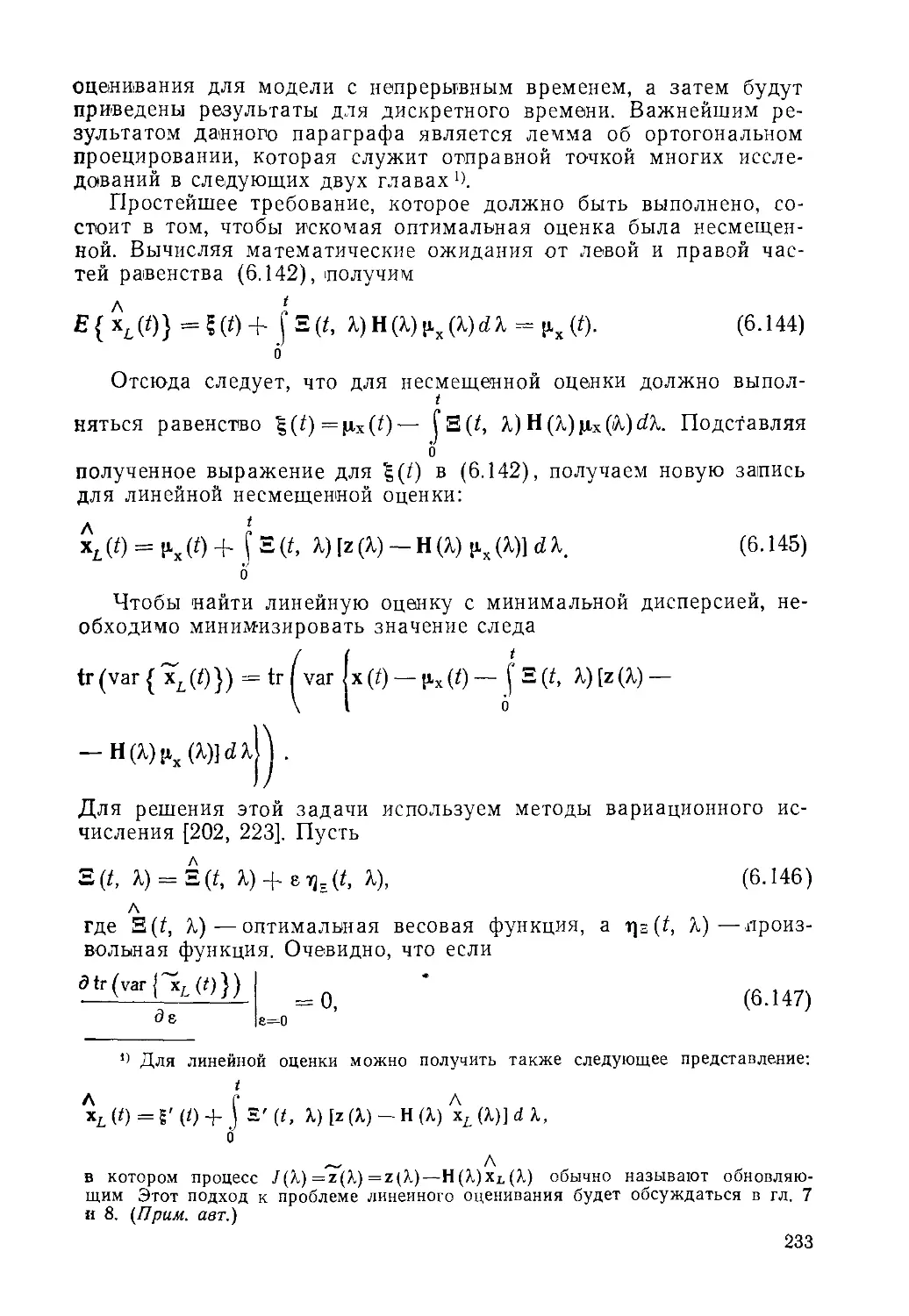

Глава 6. Основы теории оценивания. Эта глава посвящена не-

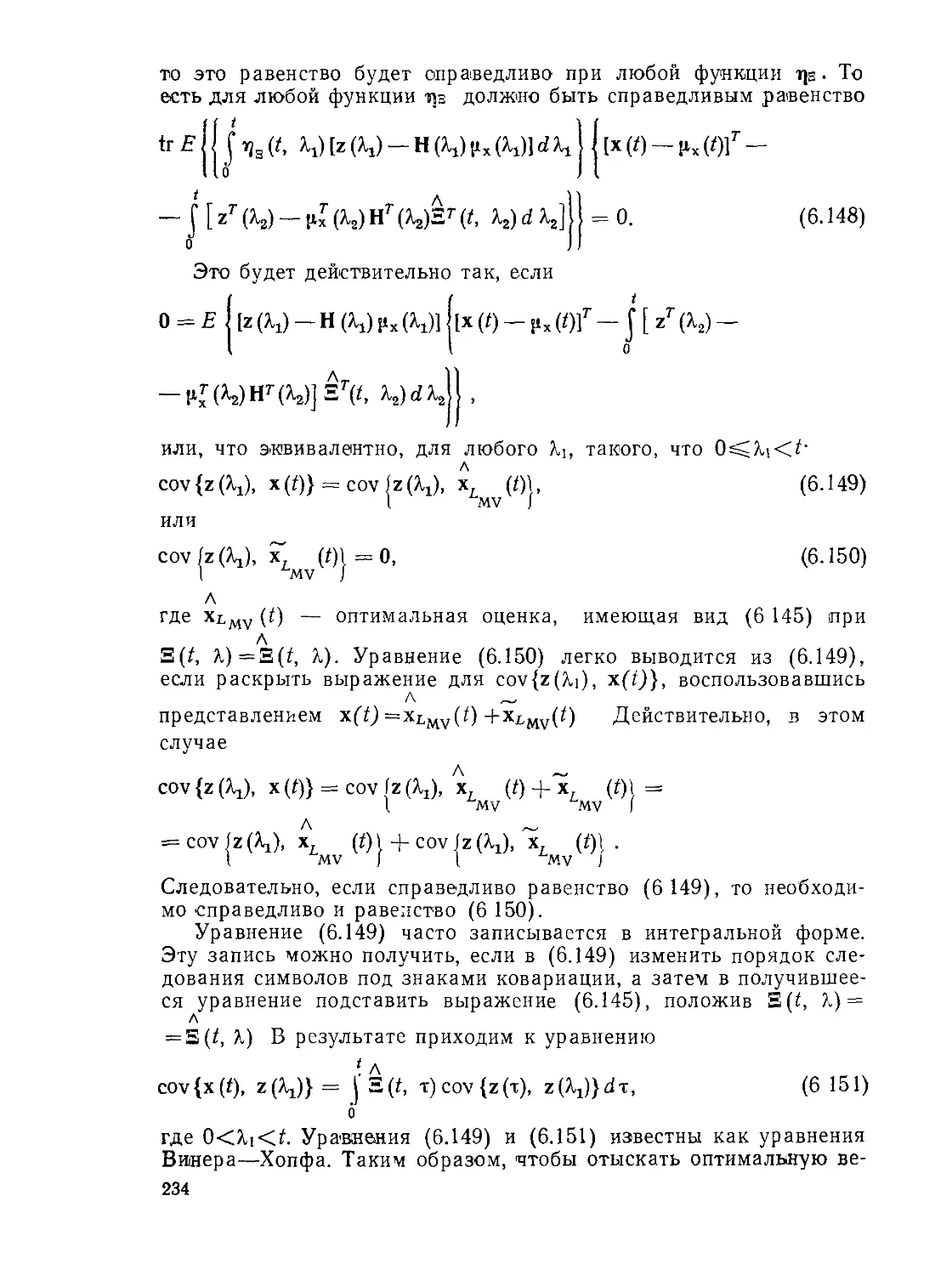

которым основным аспектам оценивания состояний и парамет-

ров — второй основной области статистических решений Основ-

ные результаты относятся к так называемым точечным оценкам.

Сначала рассматривается байесовская теория оценивания как

логическое продолжение байесовской теории решений, представ-

ленной в гл 5 При недостатке априорной информации об оцени-

ваемых параметрах используется классическая оценка макси-

мального правдоподобия. Будет сформулирован ряд свойств оце-

нок, а также будет дано понятие псевдо байесовских оценок и про-

веден анализ ошибок

Затем в предположении, что известны лишь два первых момен-

та распределения сигнала и шума, вводится ограничение линей-

ности оценки. Используя лемму ортогонального проектирования

и уравнение Винера — Хопфа, которые являются двумя наиболее

существенными в теории решений и теории оценивания, опреде-

ляется оптимальная линейная оценка.

И, наконец, для случая, когда полностью отсутствуют априор-

ные данные о сигнале и шуме, вводится оценка по методу наи-

меньших квадратов Если соответствующим образом выбрать ве-

совые матрицы и модели оценок, то можно показать, что такая

оценка эквивалентна оценке максимального правдоподобия или

байесовской оценке

Глава 7. Оптимальный линейный фильтр. Большинство оценок,

приведенных в гл 6, не являются ни последовательными, ни ре-

куррентными в том смысле, что .наблюдения не обрабатываются

по мере их получения и оценка не корректируется по мере того,

как поступает новая информация Для получения оптимальной

оценки при помощи методов гл. 6 все наблюдения обрабатывают-

ся одновременно Если же наблюдения обрабатываются по мере

их поступления, то может быть получена значительная экономия

объема вычислений. Часто такая последовательная обработка

следует из самой природы оценки.

7

В гл. 7 рассматривается решение задачи о последовательной

нестационарной линейной оценке с минимальной дисперсией ошиб-

ки, данное Калманом, Бьюси и другими, как развитие основной

работы Винера. Вначале рассматривается дискретный вариант

задачи, при этом для решения используется лемма ортогонального

проектирования. Затем для того, чтобы можно было использовать

байесовский метод, вводится предположение о нормальном зако-

не распределения сигнала и шума. При этом будет показано, что

линейная оценка с минимальной дисперсией ошибки совпадает с

байесовской оценкой.

Алгоритмы непрерывного во времени оценивания получаются,

если предположить, что выборки производятся достаточно часто.

Приводятся результаты для классического фильтра Винера и Об-

суждаются вопросы, связанные с устойчивостью алгоритмов и их

асимптотическими характеристиками.

Глава 8. Обобщение результатов теории оптимальной линей-

ной фильтрации. Основное предположение, используемое в гл. 7,

состоит в том, что шумы объекта и шумы измерения — белые.

Для учета коррелированное™ шумов объекта достаточно три-

виальное расширение вектора переменных состояния. Значительно

сложнее определить оптимальный фильтр, если коррелированы

шумы, присутствующие в наблюдении или измерении В связи

с этим предлагается несколько методов обработки сигналов для

различных подклассов задачи измерения коррелированного шума.

Последовательные процедуры, приведенные в гл 7, не при-

способлены для Оценок, учитывающих наблюдения, поступающие

в более позднее время. Однако во многих задачах учет таких на-

блюдений, так называемое сглаживание, весьма желателен.

В гл 8 дается новый метод синтеза алгоритмов сглаживания для

фиксированного интервала, фиксированного запаздывания и фик-

сированной Т0”КИ

Далее обсуждается влияние некорректного выбора априорных

дисперсий параметров и моделей сообщения и наблюдений, а так-

же излагаются процедуры анализа ошибок и устойчивости при

фильтрации и сглаживании Глава заканчивается рассмотрением

понятия расходимости, определяющего различие между оценкой

состояния и самим состоянием, которое возрастает во времени.

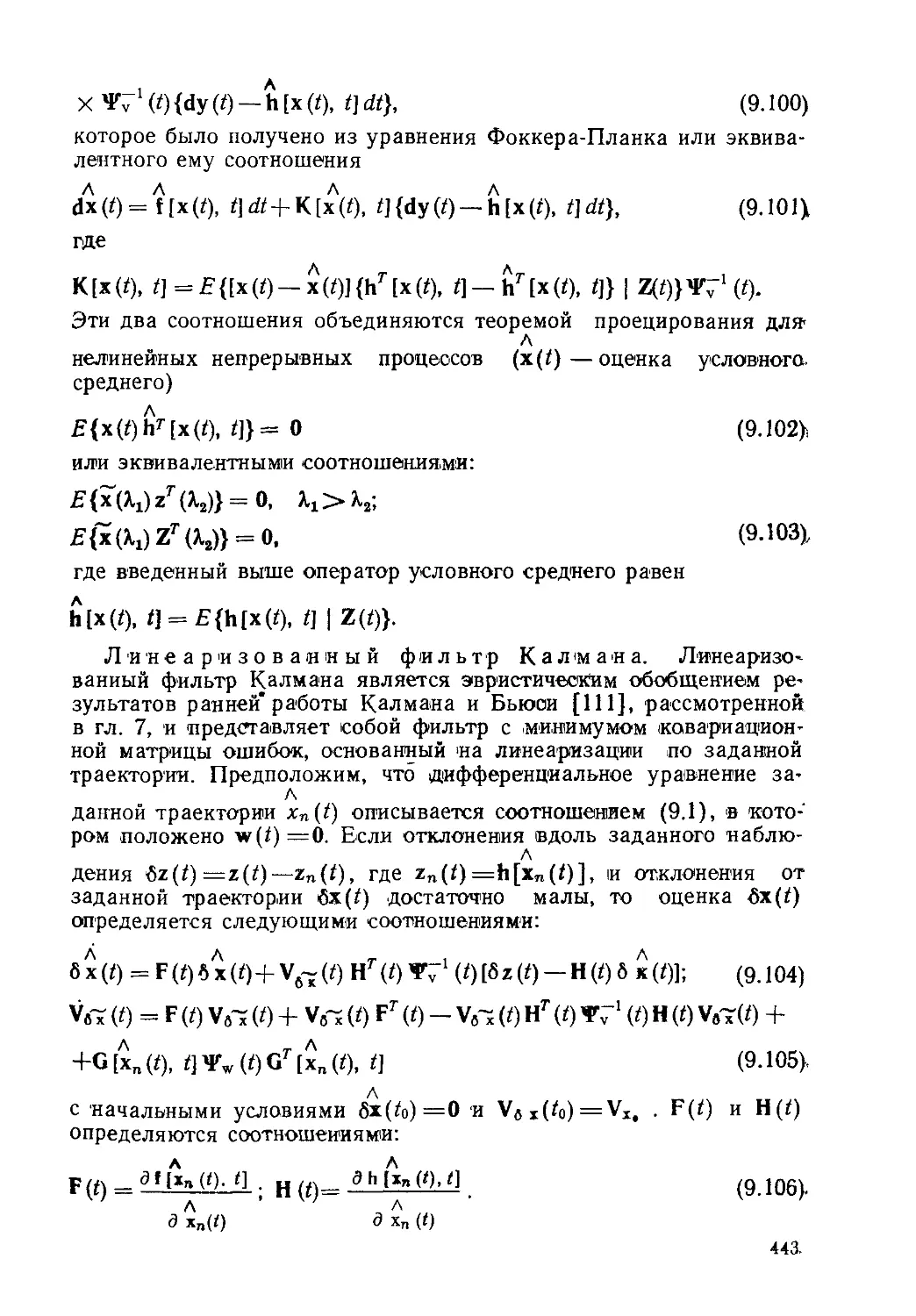

Глава 9. Нелинейное оценивание. Заключительная глава по-

священа задачам нелинейного оценивания Вновь рассматривают-

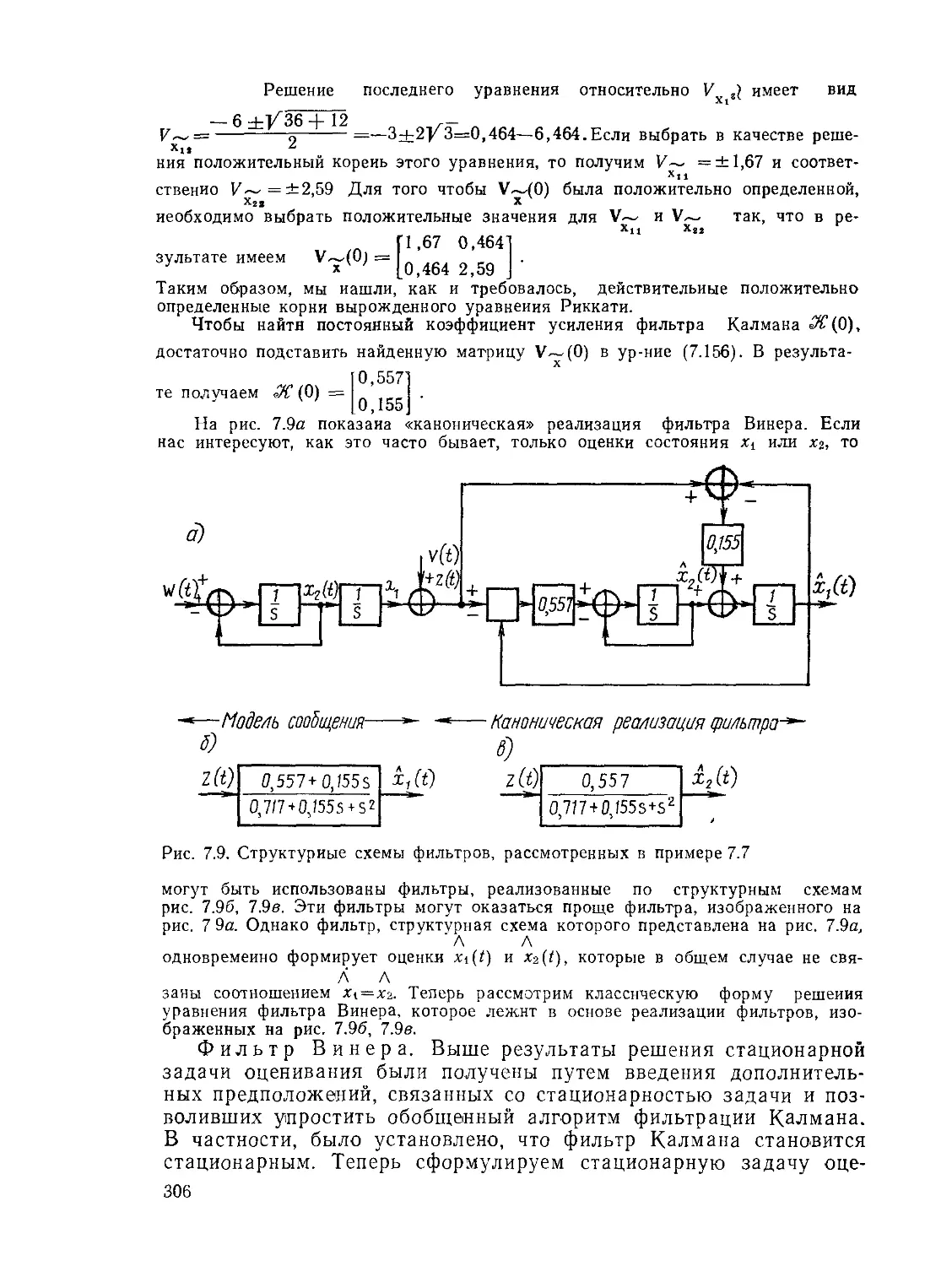

ся стохастические дифференциальные уравнения, приведенные <

в гл 4 Для случая, когда оцениваемый вектор переменных состоя-

ния зависит от наблюдения, выведено уравнение Фоккера— План-

ка Приближенные решения этого уравнения в частных производ-

ных для нелинейной фильтрации в непрерывных системах приво-

дят к физически реализуемым алгоритмам вычислений Затем по-

казано, в каких случаях дискретная оценка максимальной апос-

териорной вероятности эквивалентна оценке, полученной по методу

наименьших квадратов

8

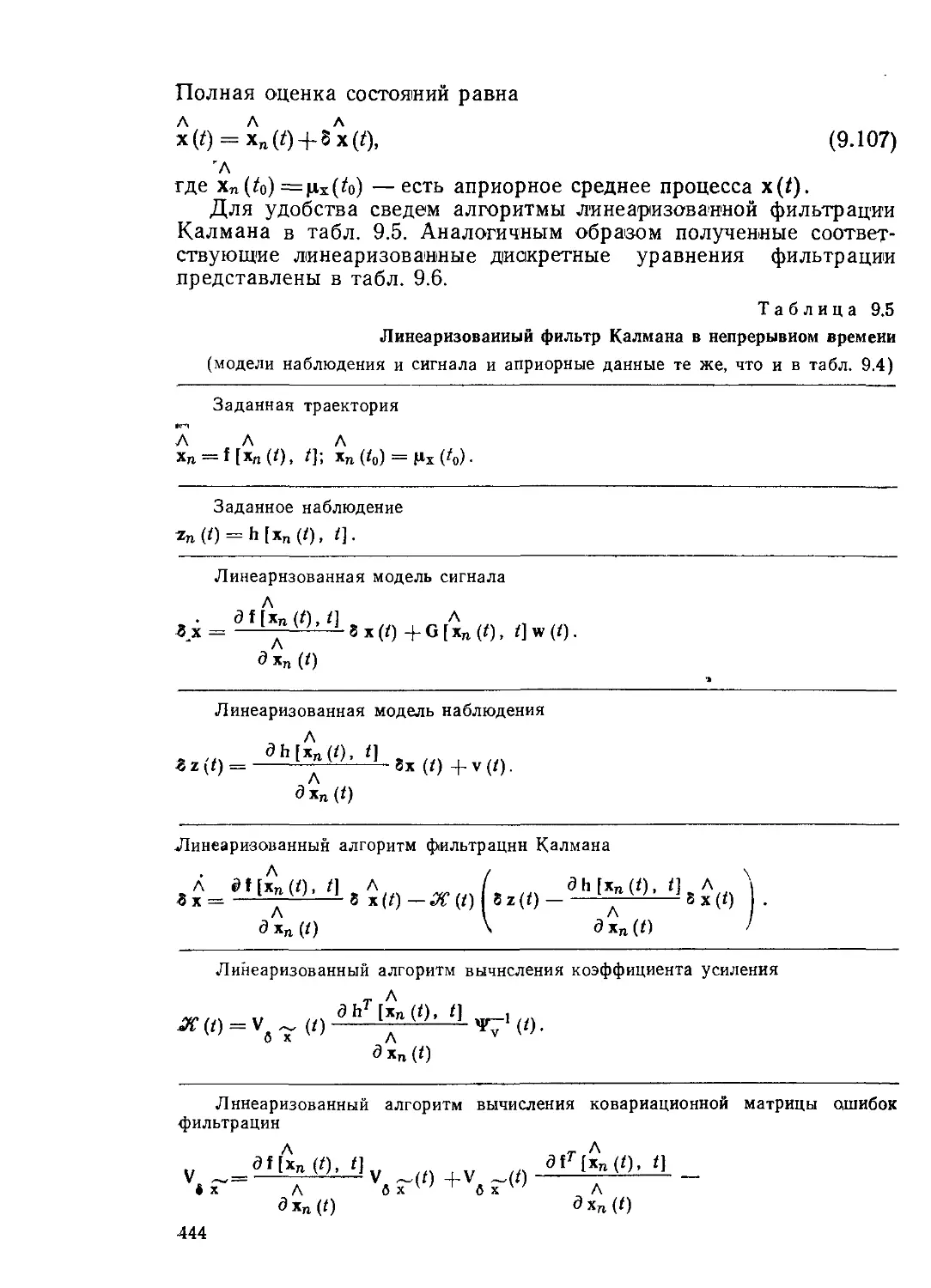

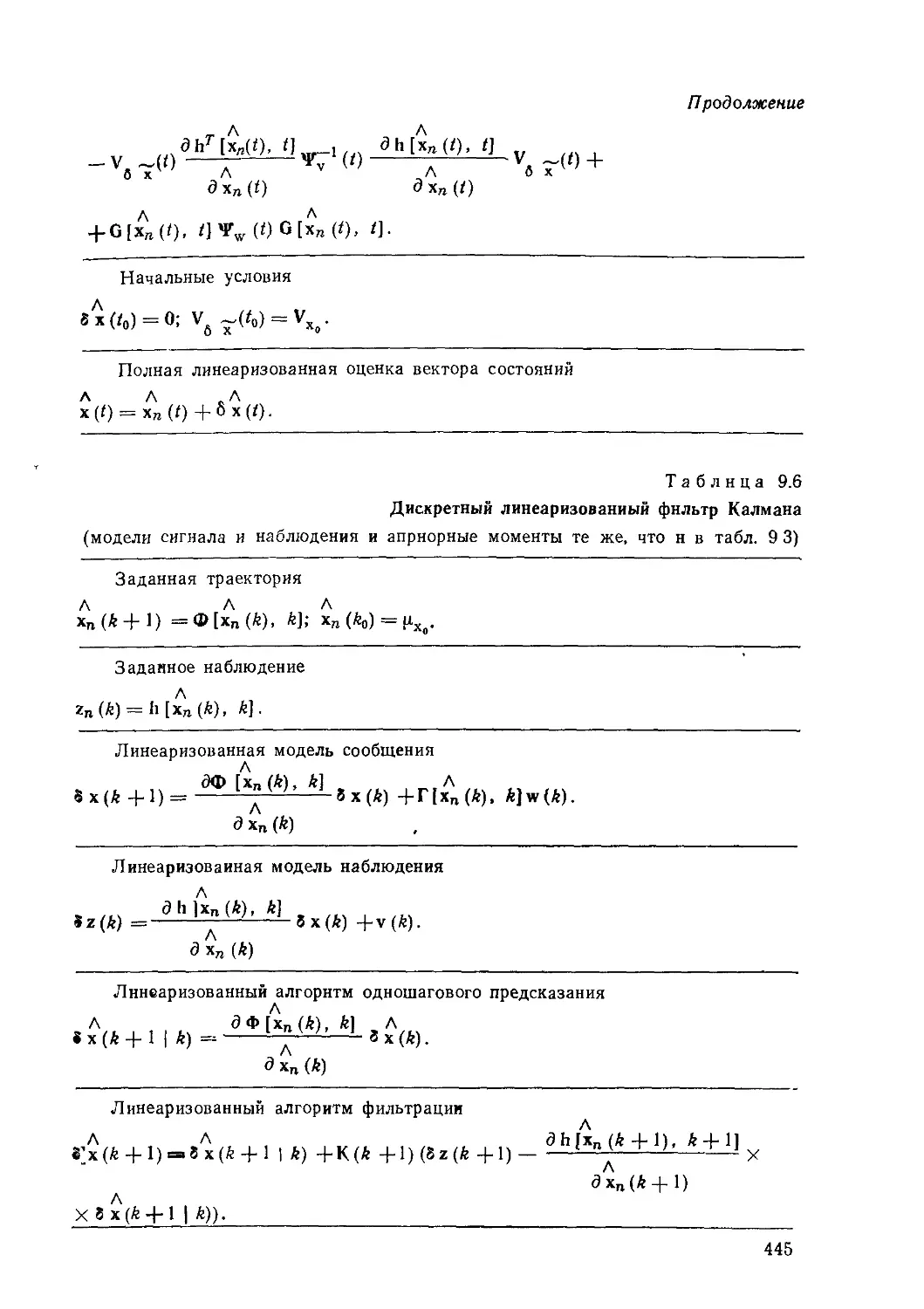

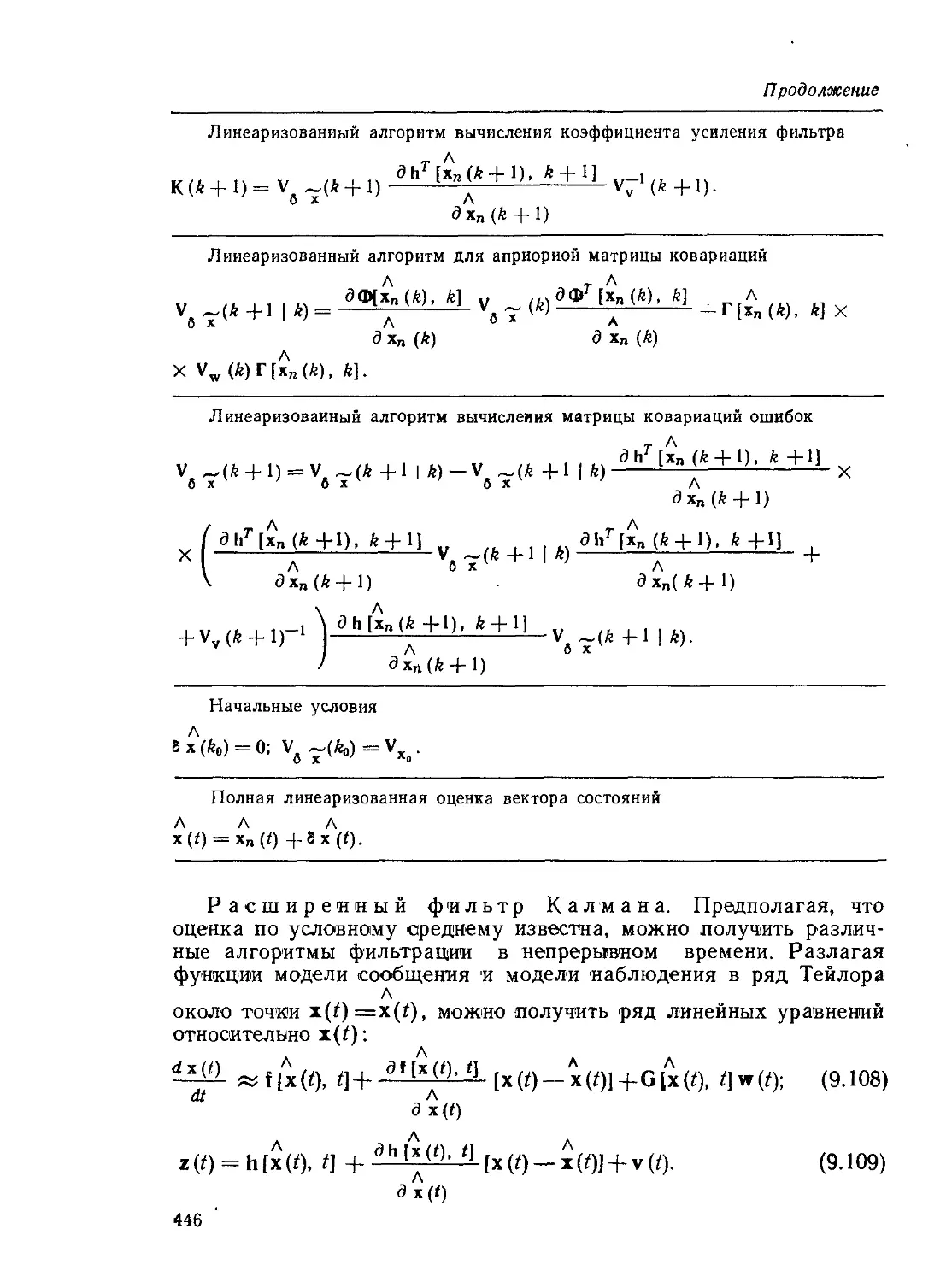

Обобщенные алгоритмы нелинейной фильтрации для дискрет-

ного и непрерывного случаев получаются с помощью линеариза-

ции нелинейных моделей сообщений и наблюдений и применения

теории линейной фильтрации. С помощью теорем об условных

средних нормальных случайных величин получены псевдобайесов-

ские алгоритмы нелинейной дискретной фильтрации. Приведен

пример, иллюстрирующий сходство и различие некоторых алго-

ритмов нелинейной фильтрации. Наконец, представлены байесов-

ские алгоритмы сглаживания и предсказания.

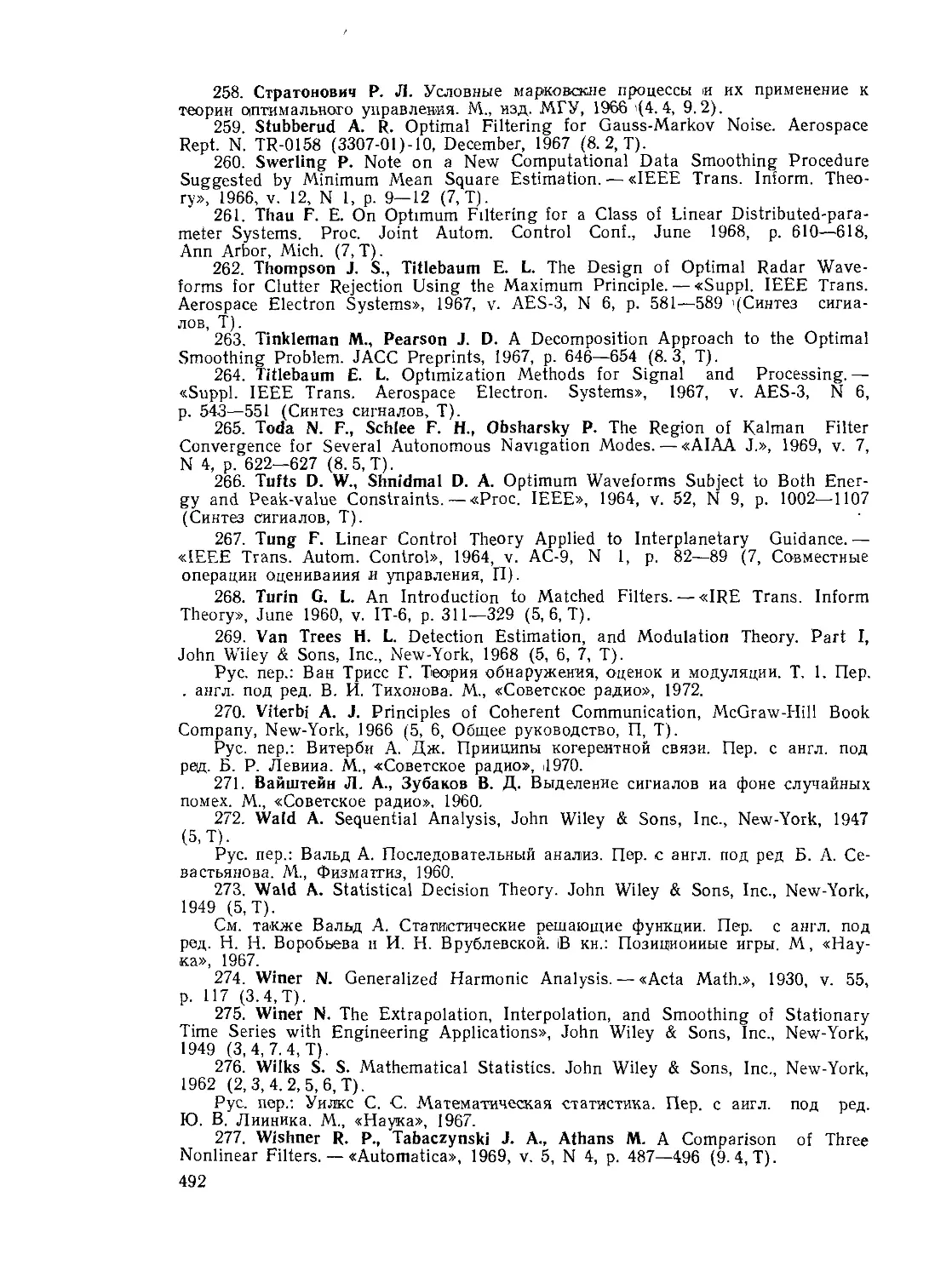

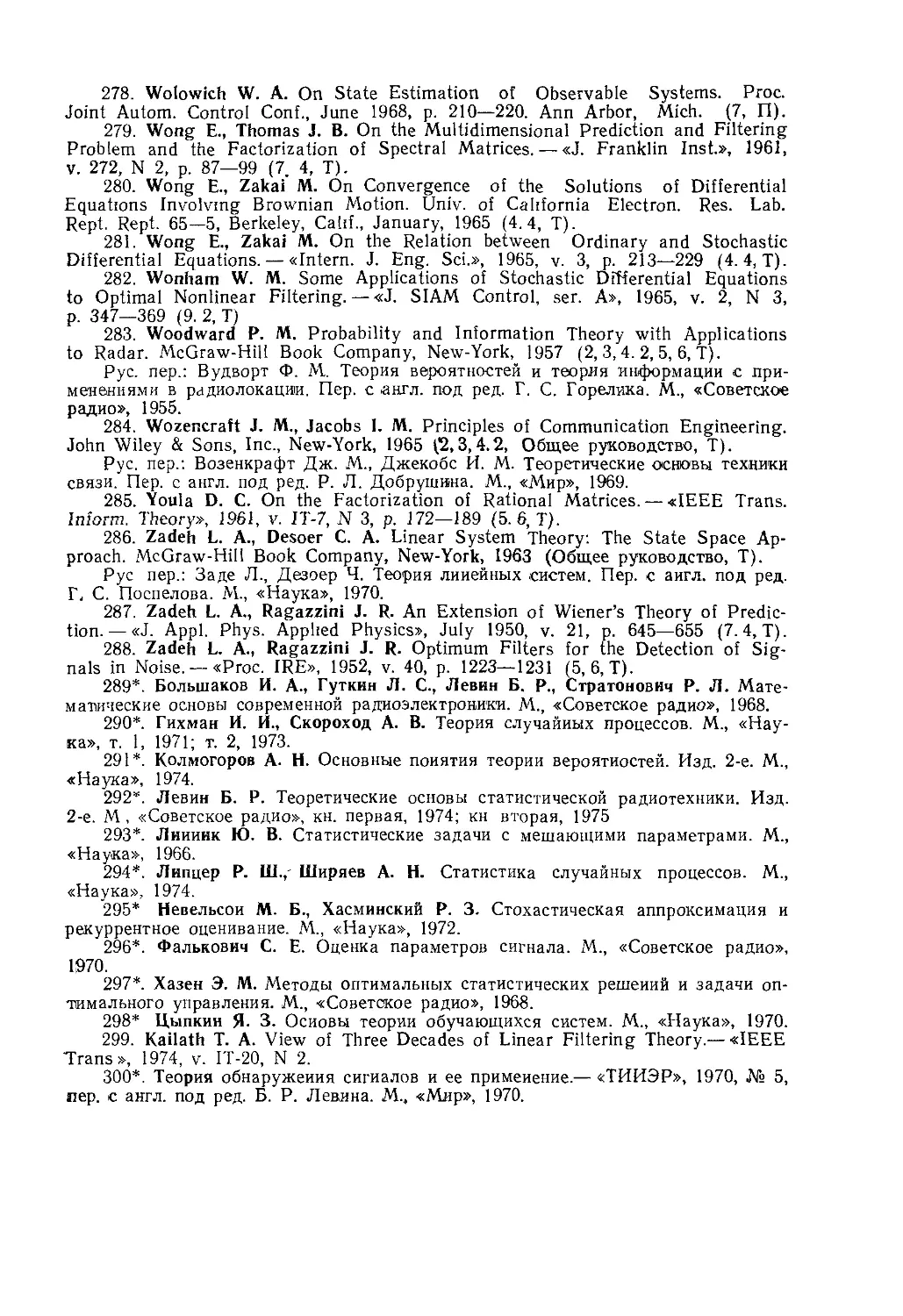

Библиография. В библиографии дан в алфавитном порядке

список многих ранее опубликованных работ, относящихся к тео-

рии оценок и ее приложениям в связи и управлении. Список снаб-

жен примечаниями, в которых указано, к какому разделу(ам)

или главе(ам) больше всего относится данная ссылка, для того

чтобы ориентировать читателя при выборе работ, подходящих к

данному разделу1).

*) Работы, включенные в библиографию редактором перевода, отмечены

звездочками (Прим отв ред)

Глава 2

ОСНОВЫ ТЕОРИИ ВЕРОЯТНОСТЕЙ

2.L Введение

В любой системе связи или управления некоторые

характеристики сигналов априори неизвестны, так как передача

априори известной информации не имеет смысла. В этой главе

дан обзор тех математических методов теории вероятностей, кото-

рые имеют наибольшее применение в теории оценивания и приня-

тия решений в области связи и управления *>.

2.2. Теория вероятностей

Теория вероятностей изучает усредненные характерис-

тики событий или экспериментов, которые могут быть описаны

математически. Основное положение теории заключается в том,

что некоторые из этих средних величин приближаются к детер-

минированным величинам, когда число испытаний или наблюде-

ний возрастает. Например, при бросании монеты герб выпадает

примерно в половине случаев, если бросать монету достаточно

большое число раз.

Для того чтобы четко определить область применения теории

вероятностей, необходимо быть точным при описании экспери-

ментов, содержащих элемент случайности. Будем называть ре-

зультат эксперимента просто исходом. Набор всех возможных

исходов данного эксперимента представляет собой выборочное

пространство Q. События могут быть простыми или неразлагае-

мыми, а также составными, т. е. разлагаемыми. Например, выпа-

дение четного числа при бросании кости является составным собы-

тием, так как его можно разложить на три простых события: по-

явление двойки, четверки и шестерки.

Отношение числа случаев, когда появляется событие, к обще-

му числу испытаний называется относительной частотой появле-

ния события. Когда число испытаний неограниченно возрастает,

мы говорим об относительной частоте как о вероятности появле-

*> Для более детального ознакомления с теорией вероятностей и случайных

процессов читателю следует обратиться к работам, указанным в библиографии

в конце этой книги (Прим авт.).

10

ния этого события. Таким образом, запишем вероятность Рх(а)

появления события Ч х=а в виде * 2>

Р (a)Al™

х N-ы, N

(2.1)

где «х(а)—число случаев появления события х-ад N — общее

число испытаний. Здесь х относится к событию, а а — к значению

этого события. Для простоты изложения предположим, что собы-

тия аг независимы, так что никакие два события а; и а3 не могут

появиться одновременно.

Если выборочное пространство состоит из М независимых со-

м

бытий di, <Х2,

, ам, то

N='£nx(al)

i=i

так что

м

2 Пх (“г) и

l = 2L=|im-‘A----------= УПт

N N-+CO N N-±a, N

1=1

Z=1

(2.2)

Другими словами, сумма вероятностей независимых событий, ко-

торые составляют выборочное пространство, равна единице. Кро-

ме того, отметим, что вероятность любого события всегда неотри-

цательна.

Иногда два эксперимента проводятся одновременно и необхо-

димо определить вероятность появления события х=а в первом

эксперименте и события у—^ во втором. Из ур-ния (2.1) непо-

средственно следует:

Рх (а) = lim ; Рв ф) = lim . (2.3)

./V—>оо N N—><x> N

Но эти две вероятности не полностью описывают возможные исхо-

ды эксперимента, так как представляет интерес также вероят-

ность совместного появления событий х=а и у=$. Если пред-

положить, что события появляются совместно пХ:У(а, р) раз, то

вероятность того, что х = а и г/= р, равна 3 * S))

рх. у (а, £) A lim ——

(2.4)

*; Часто вероятность события обозначают PfAJ. ЭтоАюжет привести к

путанице, в то время как мы бы хотели провести четкое различие между функ-

циональной зависимостью и значением функции. (Прим авт.).

2) Символ Д означает равенство по определению. Здесь автор использует

определение вероятности по Мизесу. Переход к пределу не имеет строгого обос-

нования и лишен практического смысла. Частотная интерпретация понятия

вероятности означает, что в достаточно длинных сериях экспериментов частота

появления события приблизительно постоянна и близка к величине вероятности.

Аксиоматическое определение вероятности принадлежит А. Н. Колмогорову

[291*]. (Прим. ред. перевода).

S) Утверждение «вероятность того, что х=а» означает вероятность появления

события х = а (Прим, авт ).

11

' • Пусть в ф-ле (2.4) представляет интерес только одна величи-

на, например, х. Тогда число появлений события х=а равно

му

nAa')==Ynx-y(a’ <2-5)

1=1

где Му — число независимых событий, связанных с Q, т. е. fh,

Р2, , &му. Объединяя ф-лы (2.1) и (2.4), получим

му

Рх(а) (“’₽.)• (2.6)

Х = 1

Подобным же образом находим

РйФ) = уРх.й(а1, Р), (2.7)

4ми>

1=1

где Мх — число независимых событий в пространстве О, т. е. ои,

аг, ..., ам х Функции Рж(а) и Рй(р) в ф-лах (2.6) и (2.7) назы-

ваются маргинальными (индивидуальными) вероятностями.

Нас может интересовать вероятность появления как события

х—а или события у—$, так и обоих событий. При N испытаниях

событие х=а появляется пж(а) раз, событие у=$ появляется

нй(Р) раз, события х=а и у=р совместно появляются пж,у(а, р)

раз. Число появления любого из событий х—а и у=$ равно чис-

лу появлений события х = а плюс число появлений события у=р

минус число совместных появлений этих событий. Таким образом,

Рх у(х = а или у = р) = lim

ЛГ->00

nx (а) + (Р) — пх у (а, Р)

N

= Рх(а) + Ру(₽)-/\й(а, ₽).

(2-8)

Член пх,у(а, р) надо вычитать, так как его учли дважды, один

раз в пж(а) и один раз в ну(р). Когда появление одного из собы-

тий исключает появление другого, события называются взаимно

несовместными и пЖ;1/(а, р)=0.

Типичной задачей теории связи является определение оценки

передаваемого сообщения по известному принятому сигналу.

Для решения этой задачи необходимо знать или иметь возмож-

ность вычислить Вероятность того, что передаваемое сообщение

присутствует в принятом сигнале. Таким образом, желательно

иметь возможность определить вероятность появления события

р=р при условии, что событие х=а наступило. В серии из N

испытаний событие х=а появляется пж(а) раз, а события х=а,

у=р совместно появляются пх,у(а, р) раз. При определении ус-

ловной вероятности, т. е. вероятности того, что у=^ при условии,

что х=а, необходимо рассматривать только те события, в кото-

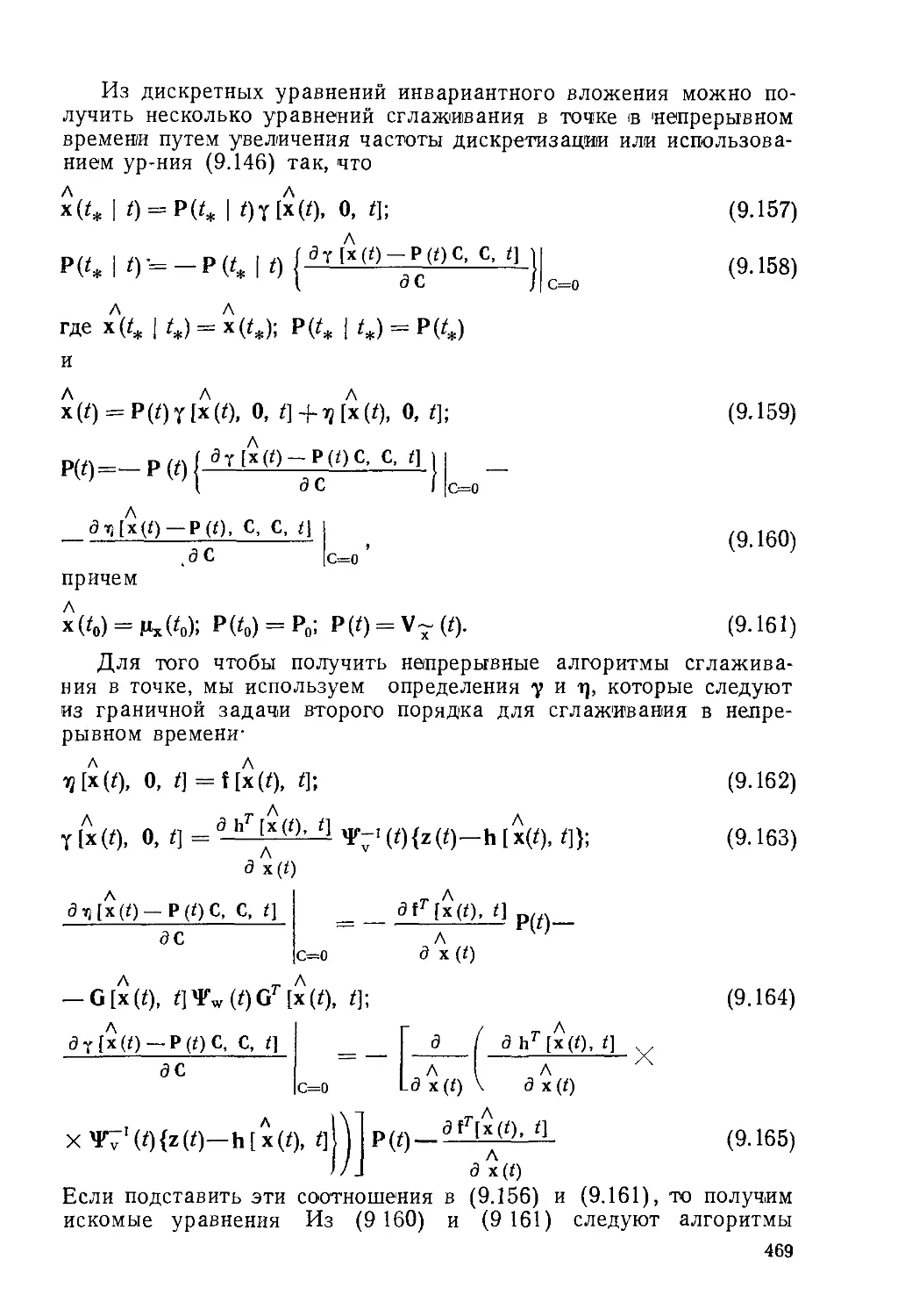

рых х—а, так как мы знаем, что событие х=а наступило. Если

число совместных появлений событий поделить на число появле-

12

ний события х=а W перейти к пределу, получим условную вероят-

ность появления события при условии, что событие х=а

наступило. Это утверждение известно как теорема о совместной

вероятности. Аналитически оно записывается в виде

. . п (а, Р) ”>-«(“> PW Рг „(а, ₽)

Ри\х Ф а) = Нт —— = Нт х’у ’— = (2.9)

#-><» пх (а) jV—Nx (a.)/N Рх (а) ’

где Рх\у (р|а) называется условной вероятностью появления собы-

тия у=р, при условии, что событие х=а наступило. Аналогично

имеем

рх|Доф) = Рх,И<х. Р)/^(Р). (2.10)

Если совместная вероятность Рж,у(а, р) является простым

произведением индивидуальных вероятностей Рх(<х} и /\(Р),

т. е.

Рж.Да,₽) = Рх(«)^Ф), (2.П)

для всех возможных а и р, то события х и у называются незави-

симыми. Из ф-лы (2 10) легко получить, что если х и у независи-

мы, то вероятность события х~а при условии у— р не зависит

от а, так что

Ру\* (₽|а) = Ру (р) (2.12)

и аналогично

Рж|Д<х|Р) = Рх(<х). (2.13)

Представляет интерес скомбинировать ф-лы (2 10) и (2 9) так,

чтобы исключить вероятность совместного появления. В результа-

те получим формулу Байеса

Р*\у (<*!₽) = Рух (₽|а) Рх (а)/Ру Ф). (2.14)

Формула или теорема Байеса широко используется в теории

оптимальных оценок. Часто известна условная вероятность при-

нятого сообщения и требуется определить условную вероятность

переданного сообщения при данном принятом сообщении. Тео-

рема Байеса дает метод получения этой вероятности.

В этом разделе были изложены основные понятия теории ве-

роятностей, базирующиеся на понятии относительной частоты

появления события Мы оставили в стороне более строгий аксио-

матический подход к теории вероятностей с тем, чтобы подчерк-

нуть физическую природу вероятности и ее связь с эксперимен-

тальными результатами.

2.3. Случайные величины

Случайная величина х(со) представляет собой действи-

тельную функцию, значение которой определяется результатом

<й произвольного эксперимента. Иначе говоря, случайная величи-

на присваивает вещественное значение каждой точке выборочного

13

пространства. В предыдущем разделе мы определяли вероятности

конечных совокупностей событий, вычисляя относительную часто-

ту появления каждого события. Для определения плотности ве-

роятности и функции распределения непрерывных случайных ве-

личин, определенных на бесконечных множествах событий, ис-

пользуется предельный переход. Важными для дальнейшего

изложения будут понятия вероятности по времени и вероятности

по ансамблю, которые непосредственно приводят к определению

случайного процесса как выборочного пространства, состоящего

из событий, являющихся функциями времени. Таким образом,

случайный процесс можно представить как совокупность функций

времени. В гл. 3 будет дан обзор теории случайных процессов.

В этой главе ограничимся только случайными величинами.

Когда выборочное пространство для случайного эксперимента

состоит из непрерывного, а значит, из бесконечного множества

значений, вероятность получения одного определенного значения

или элемента множества равна нулю. Однако сумма вероятностей

по бесконечному числу элементов во всем выборочном простран-

стве должна равняться единице В этих случаях удобно опреде-

лить функцию распределения вероятностей Fx(a) следующим об-

разом:

Fx(a)APx.[—оо<х<;а], (2.15)

где Рх(а) представляет собой вероятность того, что х меньше

или равен а. Чтобы связать это с полученной ранее дискретной

вероятностью, следует лишь отметить, что мы просто определяем

событие А, как то, что —оо<х^а, или, выражаясь более строго,

что событие А является совокупностью исходов а, принадлежа-

щих выборочному пространству Q, таких, что х(а)^‘а, т. е.

А = {а: —оо < х (а) < a); Fx (а) А Рх (Л). ; ч (2.16)

Если В представляет собой (событие

В = {а: ад < х (а) а^}, (2.17)

то, используя ф-лу (2.16), получим, что вероятность события В

P^B^FM-F^). (2.18)

Если а2=<Х1+Да, то из предыдущего выражения находим

Рх (В) __ Fх (tti 4- A tt) Fx (Од) ^2 ] g\

Да Да'

Предел в ф-ле (2.19) при Да->0, если он существует, называют

функцией плотности вероятности рх(сц):

рх(ccj) = lim + . (2.20)

да->0 Да d at

Из определения рх(В) согласно (2.18) и события В согласно

(2.17) следует, что

P-Ja: Од <х(а) < ад + Д а}] = рх (ад) Д а. (2.21

14

Таким образом, вероятность того, что событие х больше ai, но

меньше или равно ои+Ла, равно значению функции плотности

вероятности Px(ai), умноженной на Да. Из ур-ния (2.20) следует,

что функцию распределения вероятностей можно получить ин-

тегрированием функции плотности вероятности

Fx(a) = Jpx(a)da. (2.22)

— оо

Некоторые свойства плотностей вероятностей и функций распре-

деления, на которые следует обратить внимание, приведены

ниже:

fx (— °0) = 0; ^(оо) = 1; Fx < Fx (а2) для всех аг < а2; рх (а) >0 для всех а; Jpx(a)da-= 1. — оо (2.23а) (2.236) (2.23в) (2.23г) (2.23д)

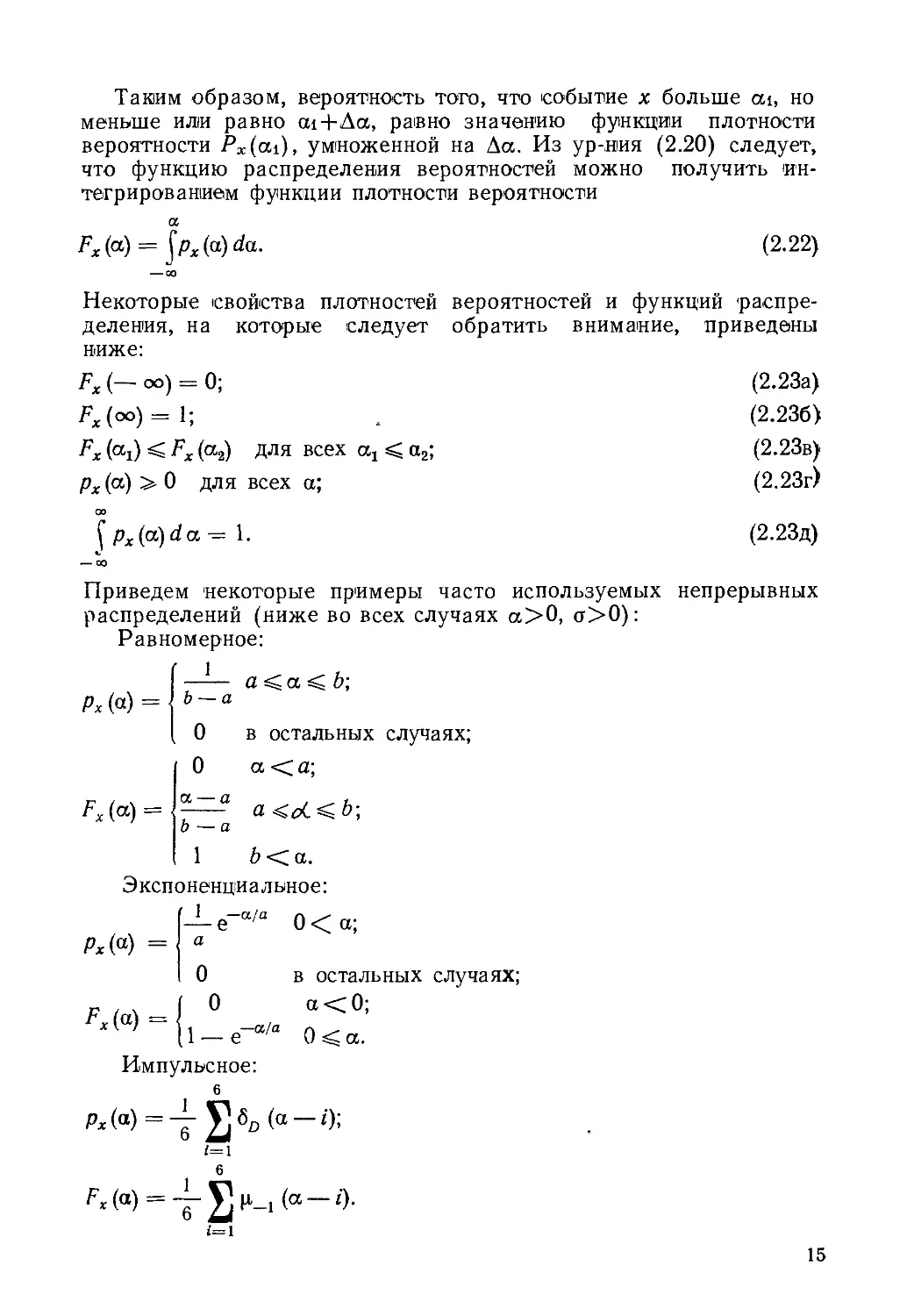

Приведем некоторые примеры часто используемых непрерывных

распределений (ниже во всех случаях а>0, <т>0):

Равномерное:

Рх (а) = 1 а sC a Ci о; Ь — а 0 в остальных случаях; 0 a <a;

Fx (“) = V/ в V/ V В <2 а । а Ч 1 - 8 1 <5

Экспоненциальное:

М«) = — ё~а/а 0 < a; а

Fx(a) = 0 в остальных случаях; 0 а<0; 1_е-“/а 0<а.

Импульсное:

6

Рх(а)=4- (а~г);

1=1

6

^(«)= о-

1=1

15

Релеевское:

Рх(“)==

О

сь е~а’/2а

а

Рх (а) — 11 е—а'/2а

а<0;

а > О;

а<0;

а > 0.

Гауссовское (нормальное):

рх (а) = yJ-— exp Г — -С-—Hl

х ' /2 л a L 2 а2

Fx(a) = erf

’ \/2сг /

Здесь 6d(t)—дельта-функция; p_i — единичная ступенчатая

функция, начинающаяся при т=0; erf — табулированный интег-

рал Ч

erf а =

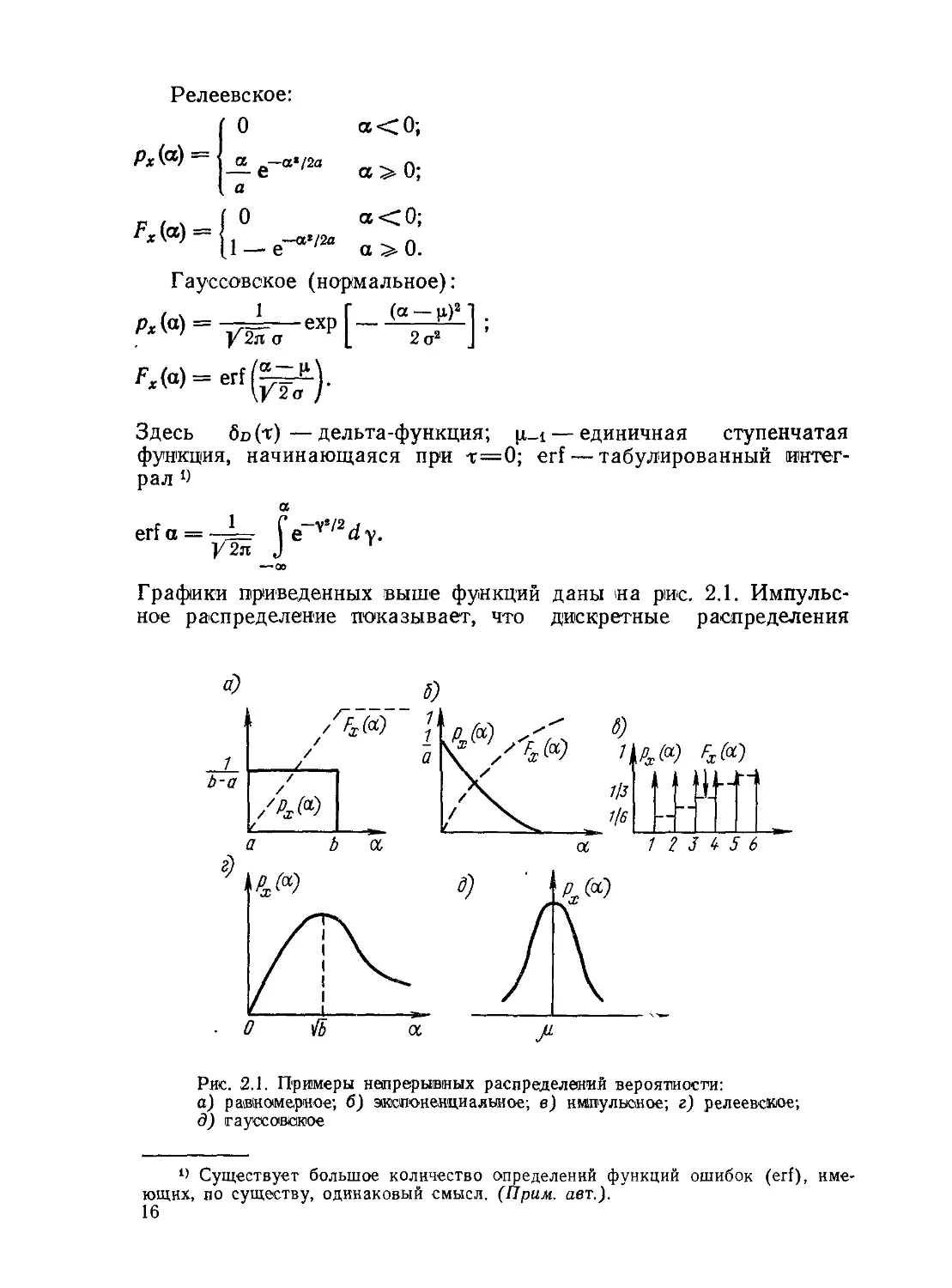

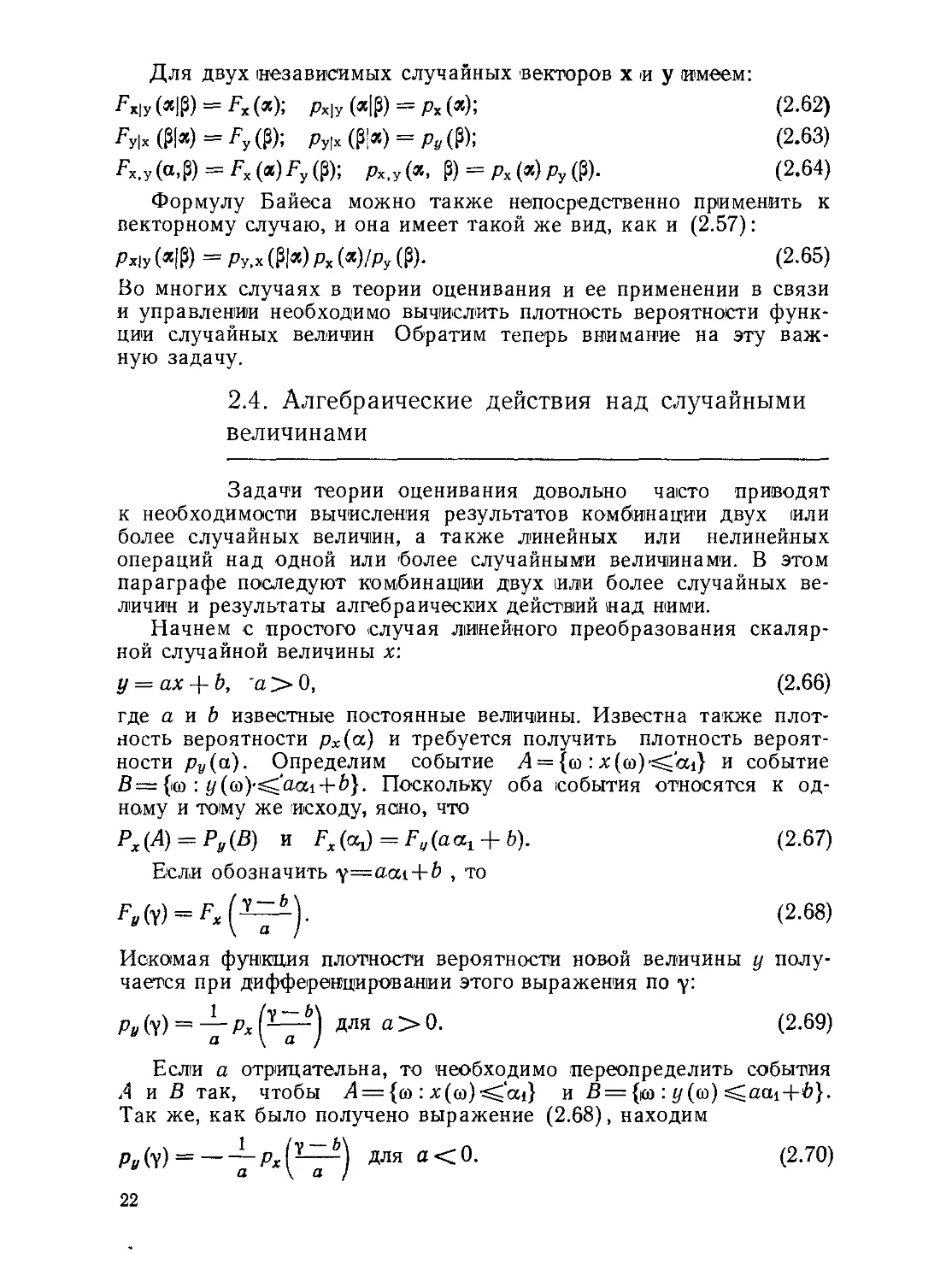

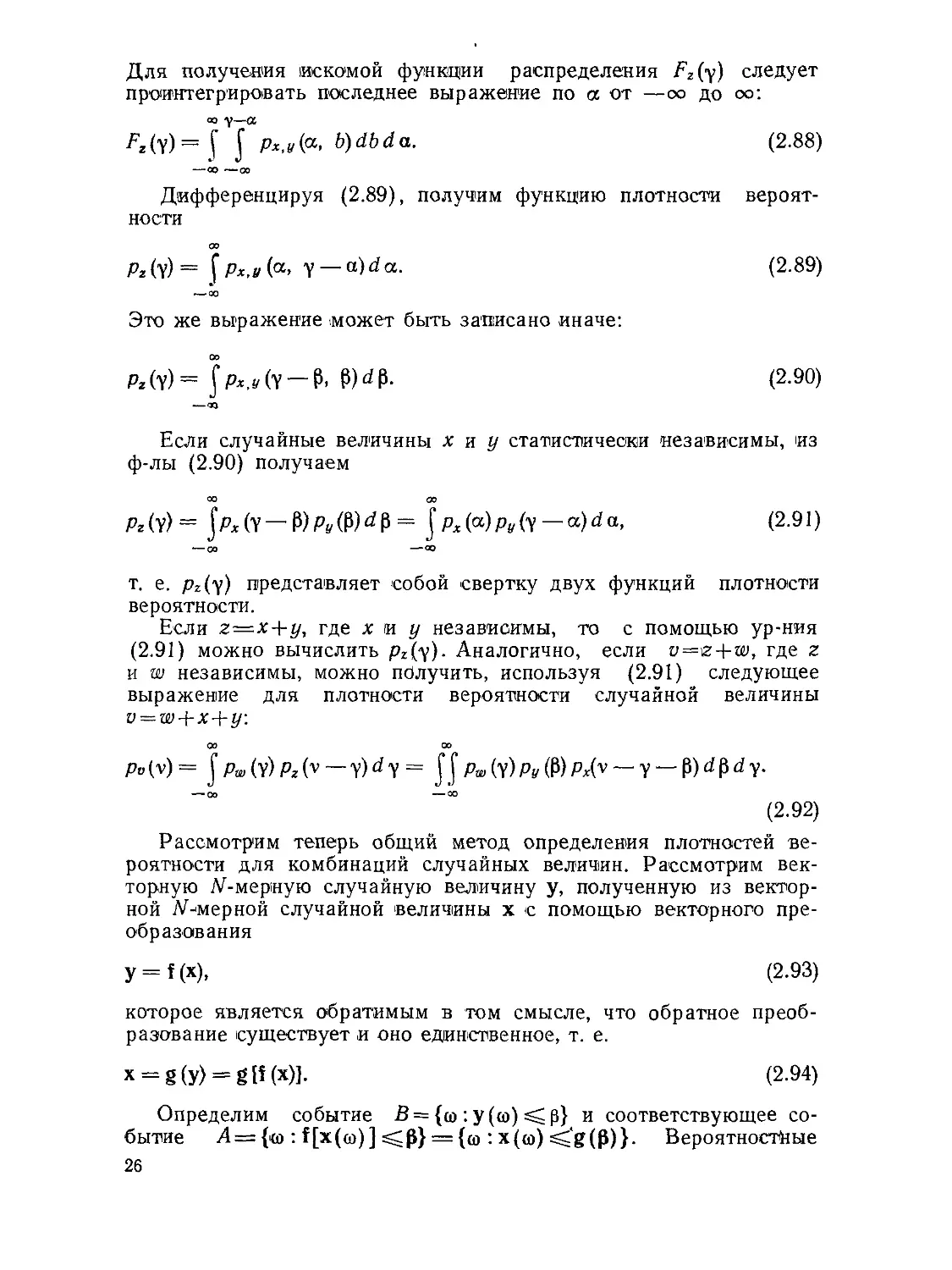

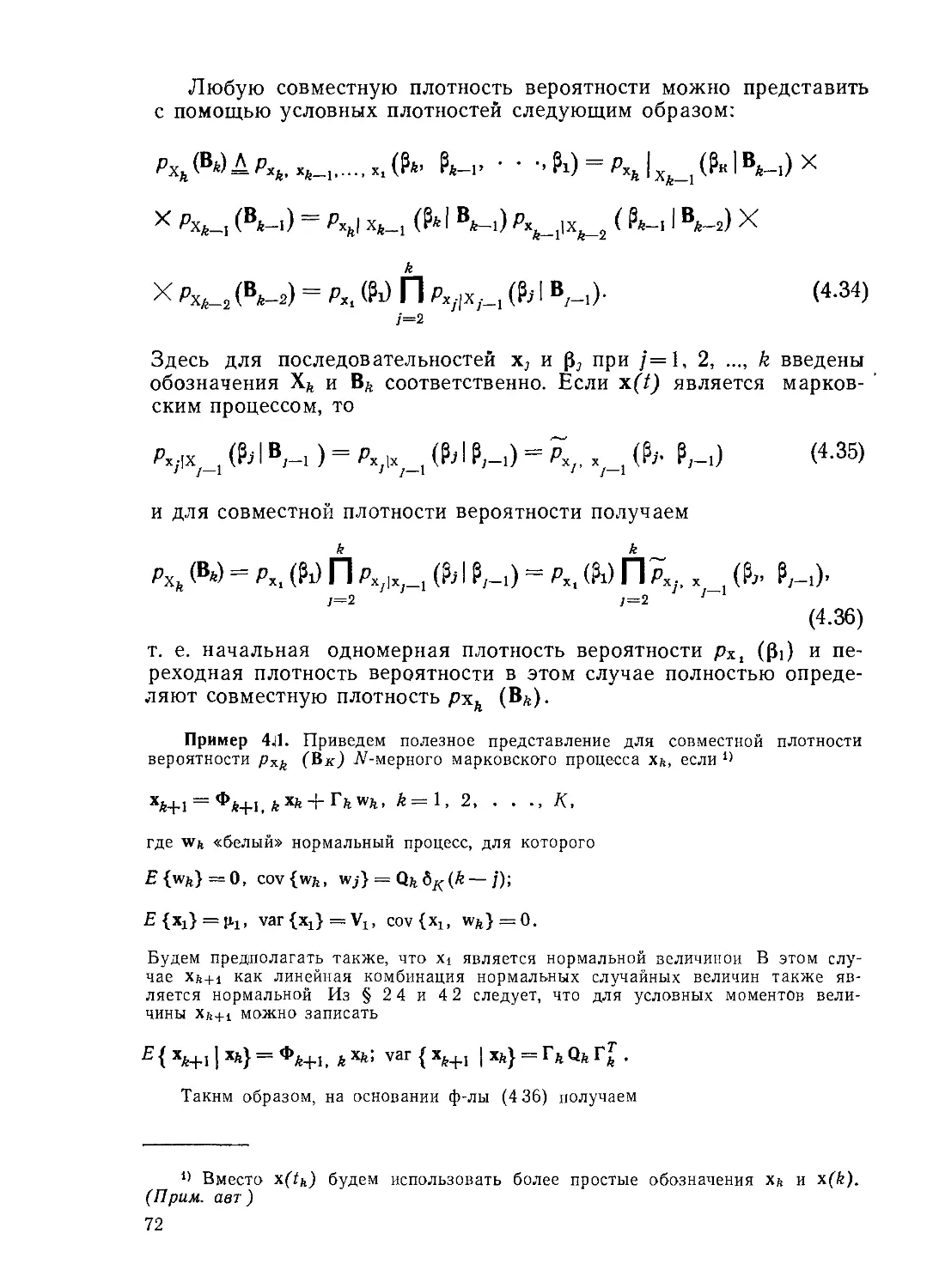

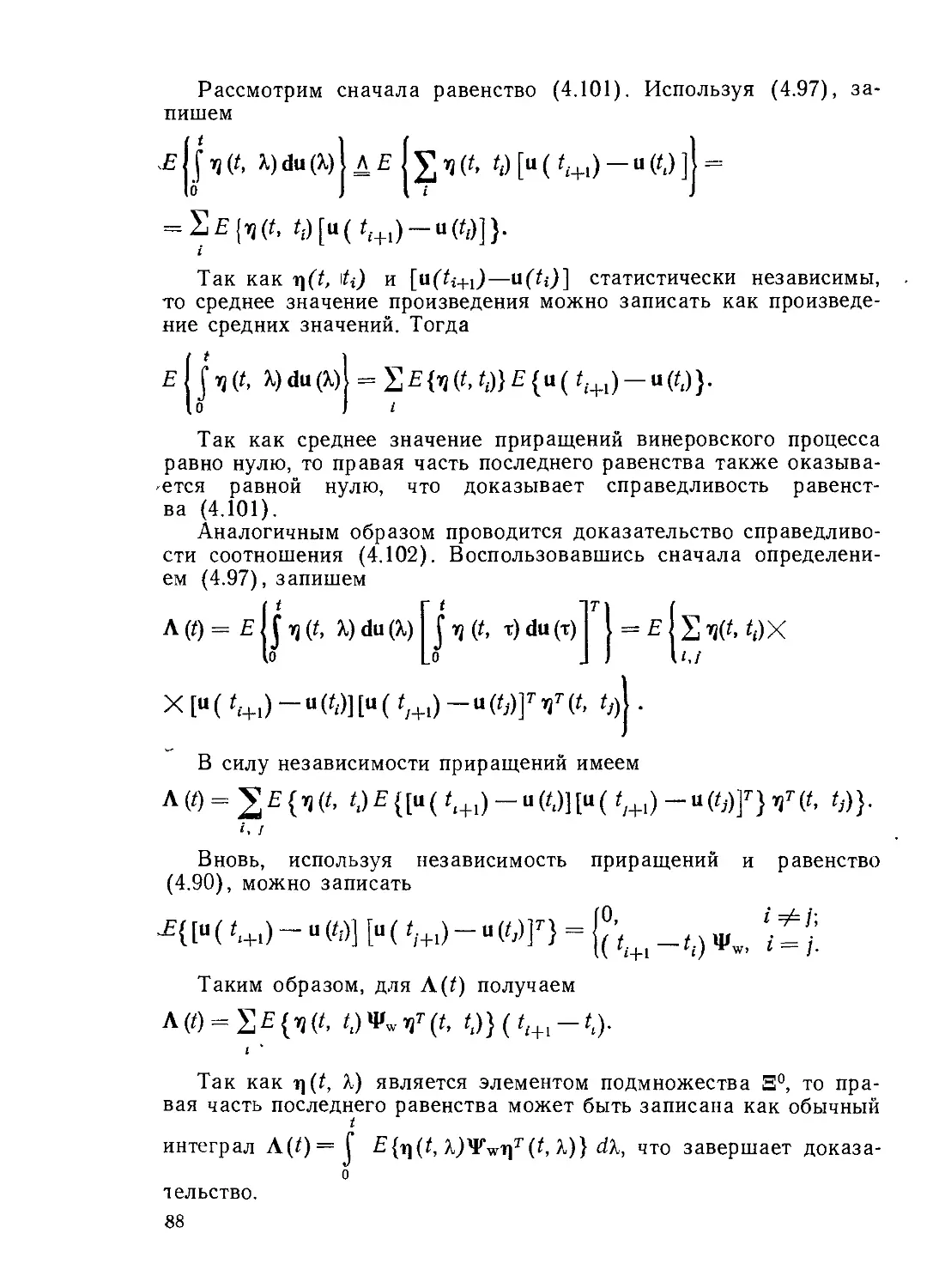

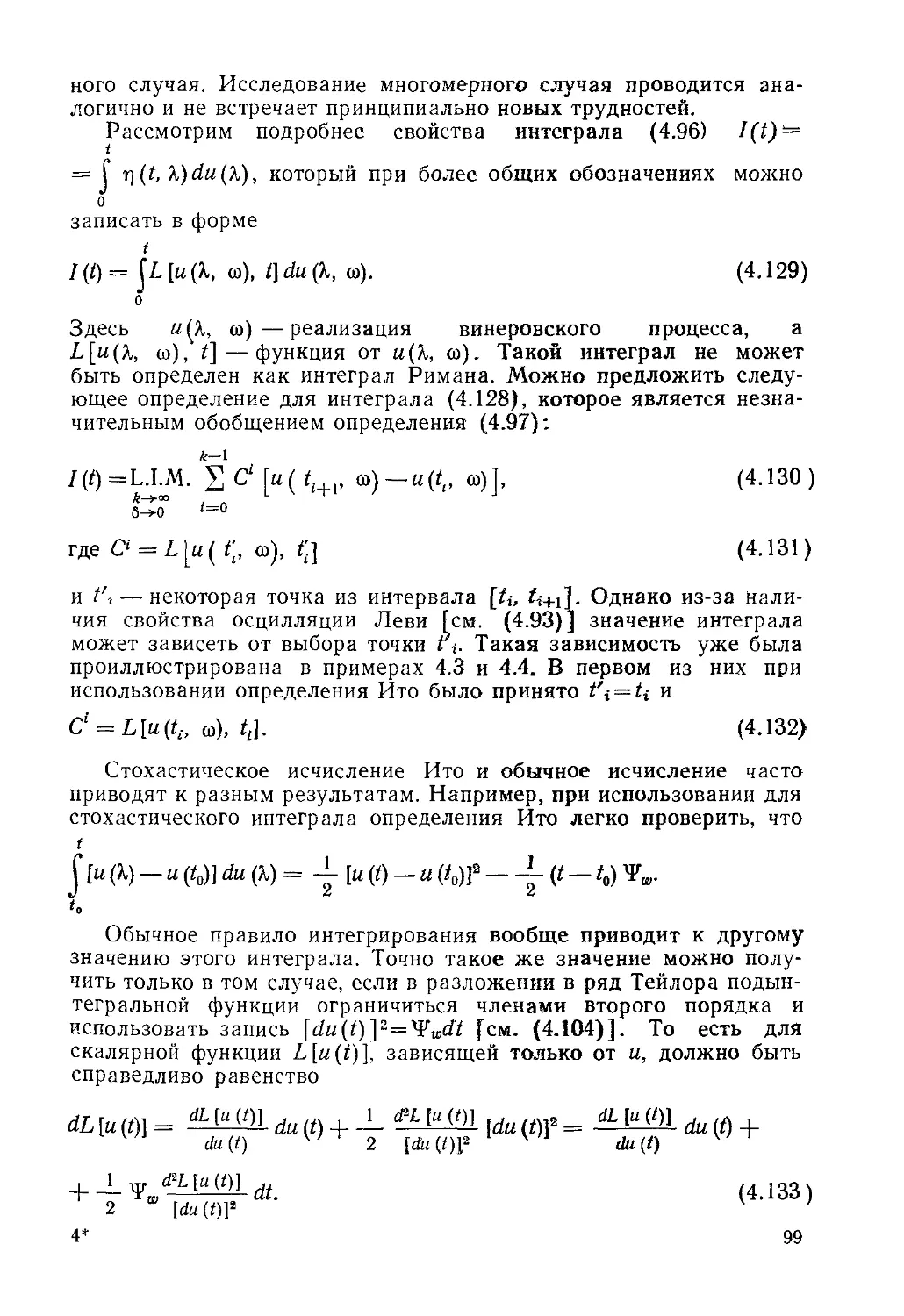

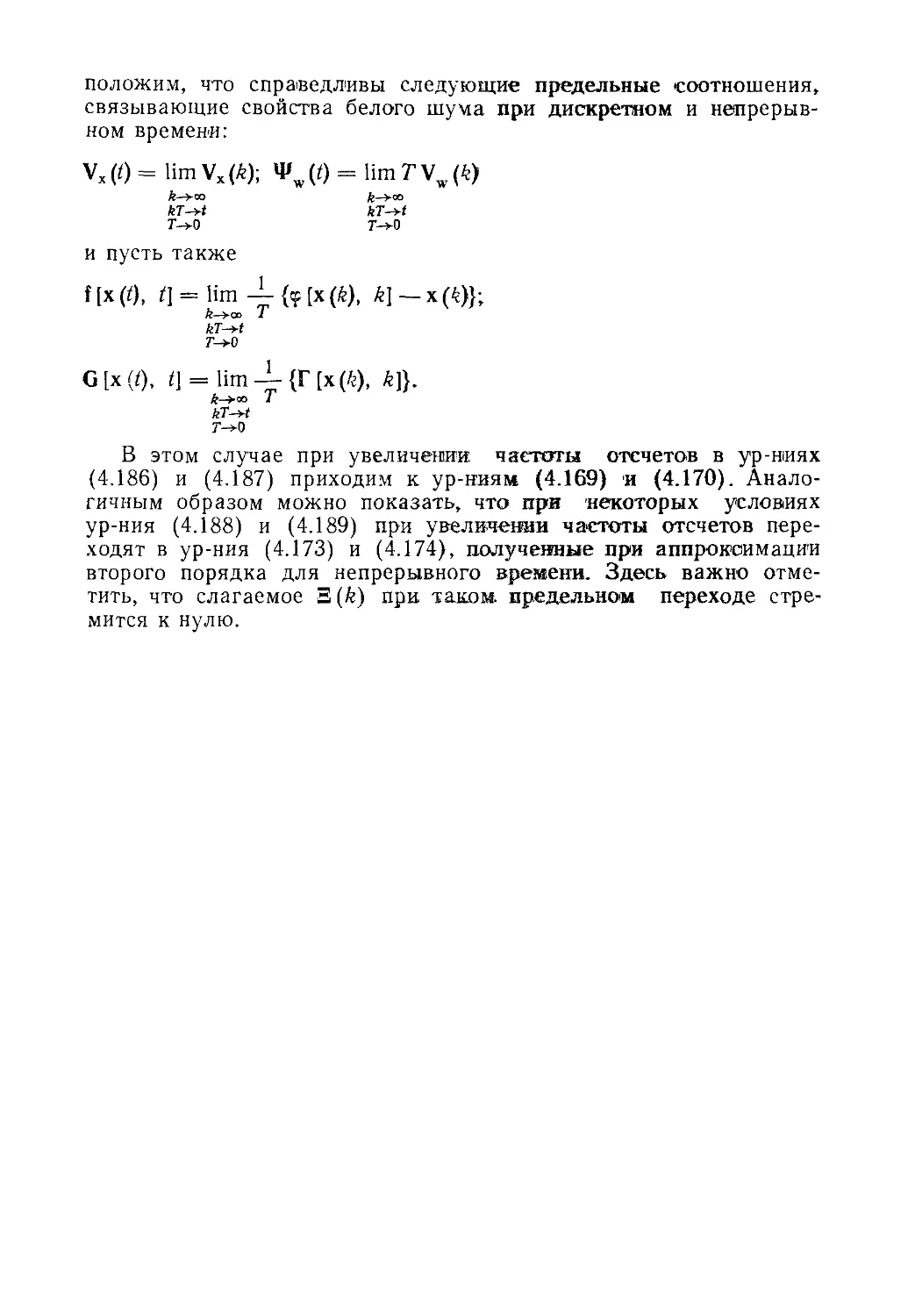

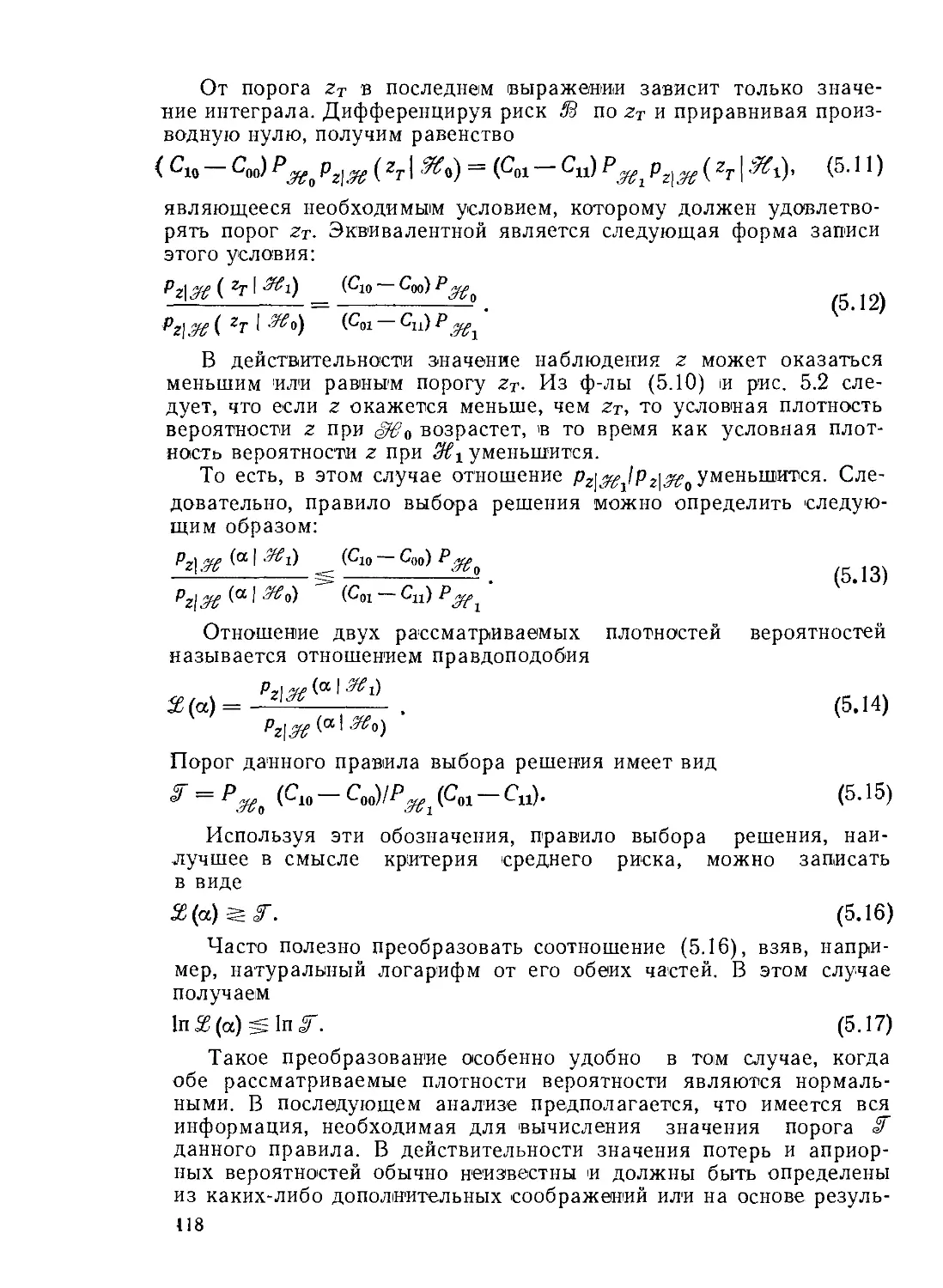

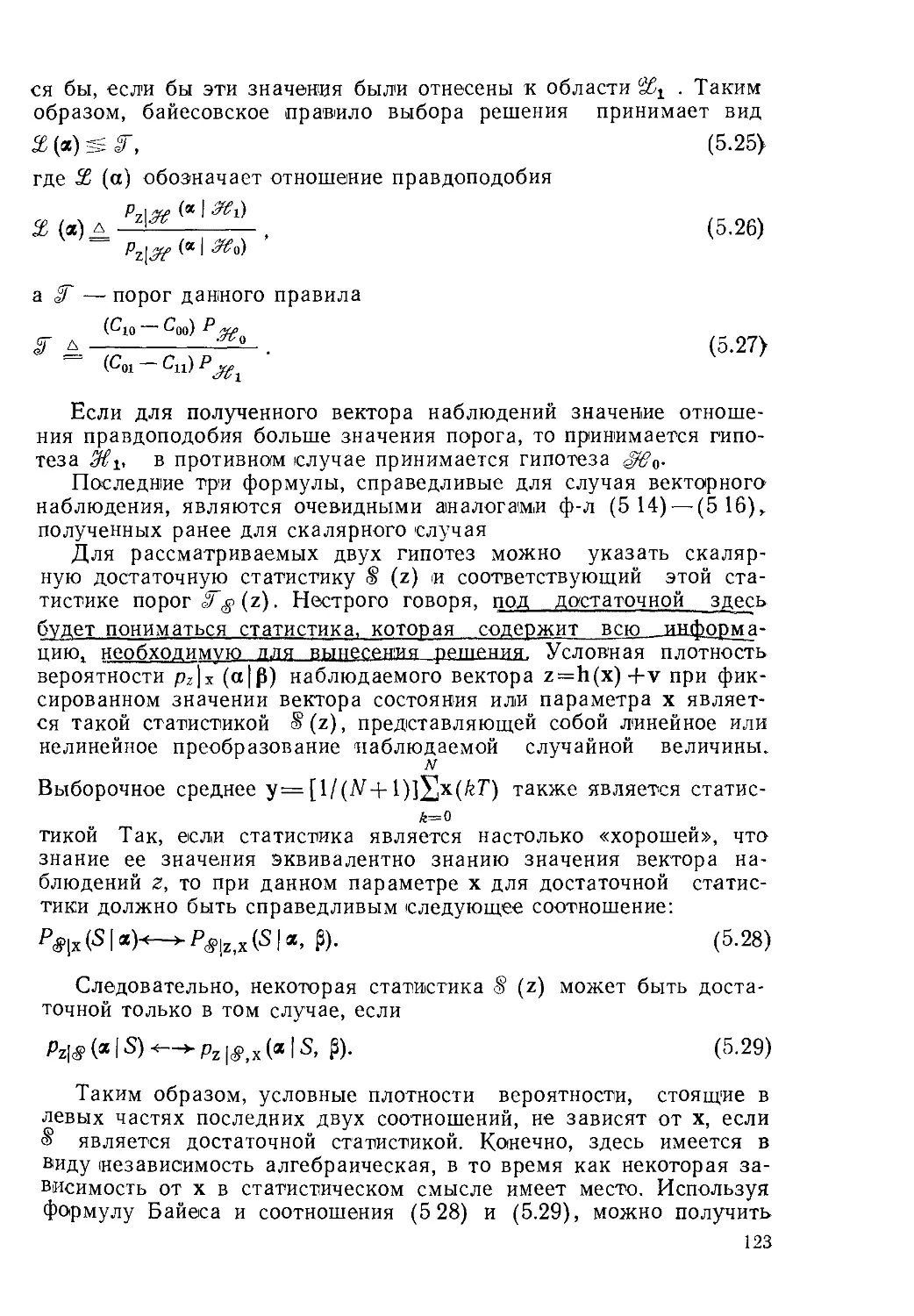

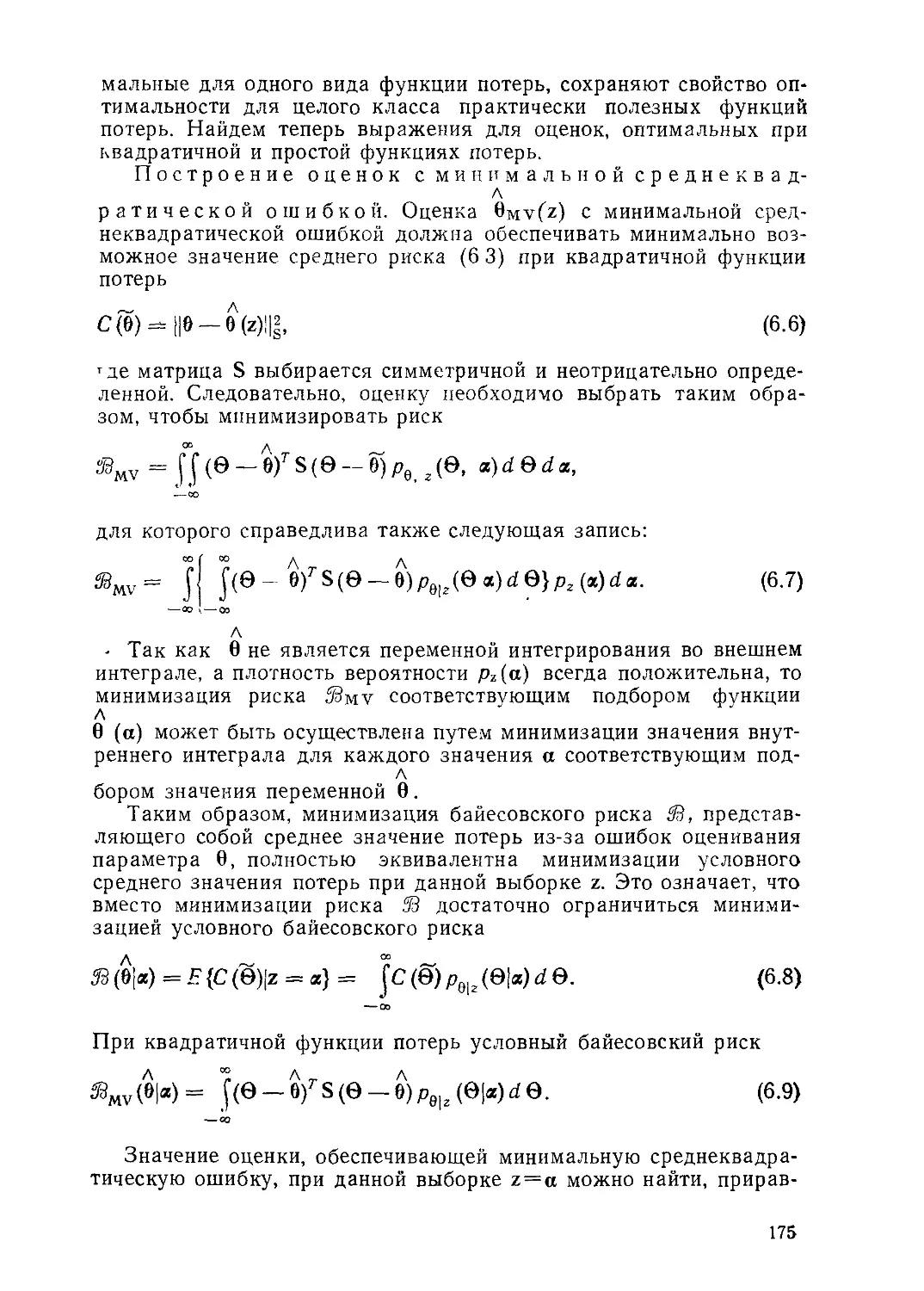

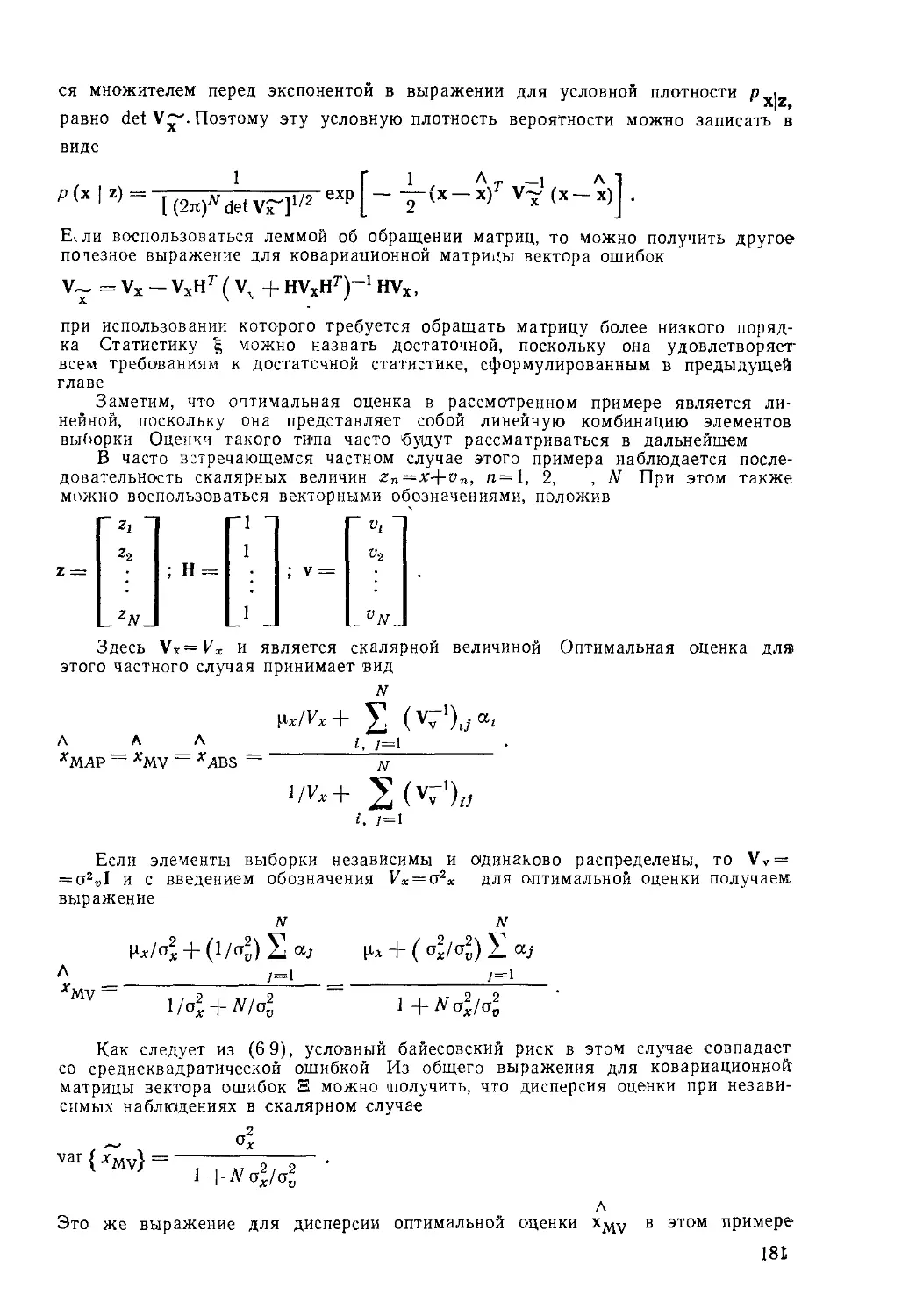

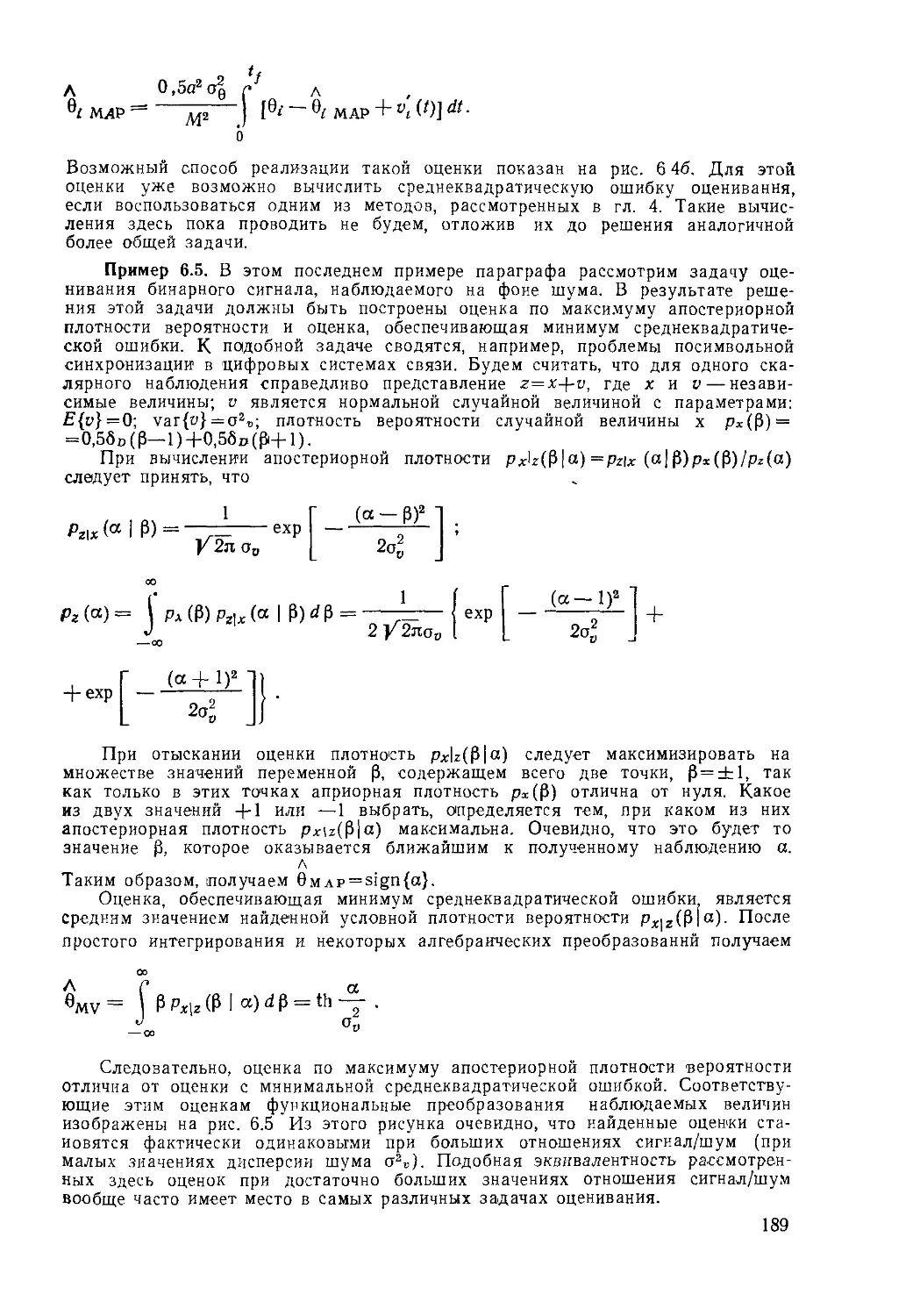

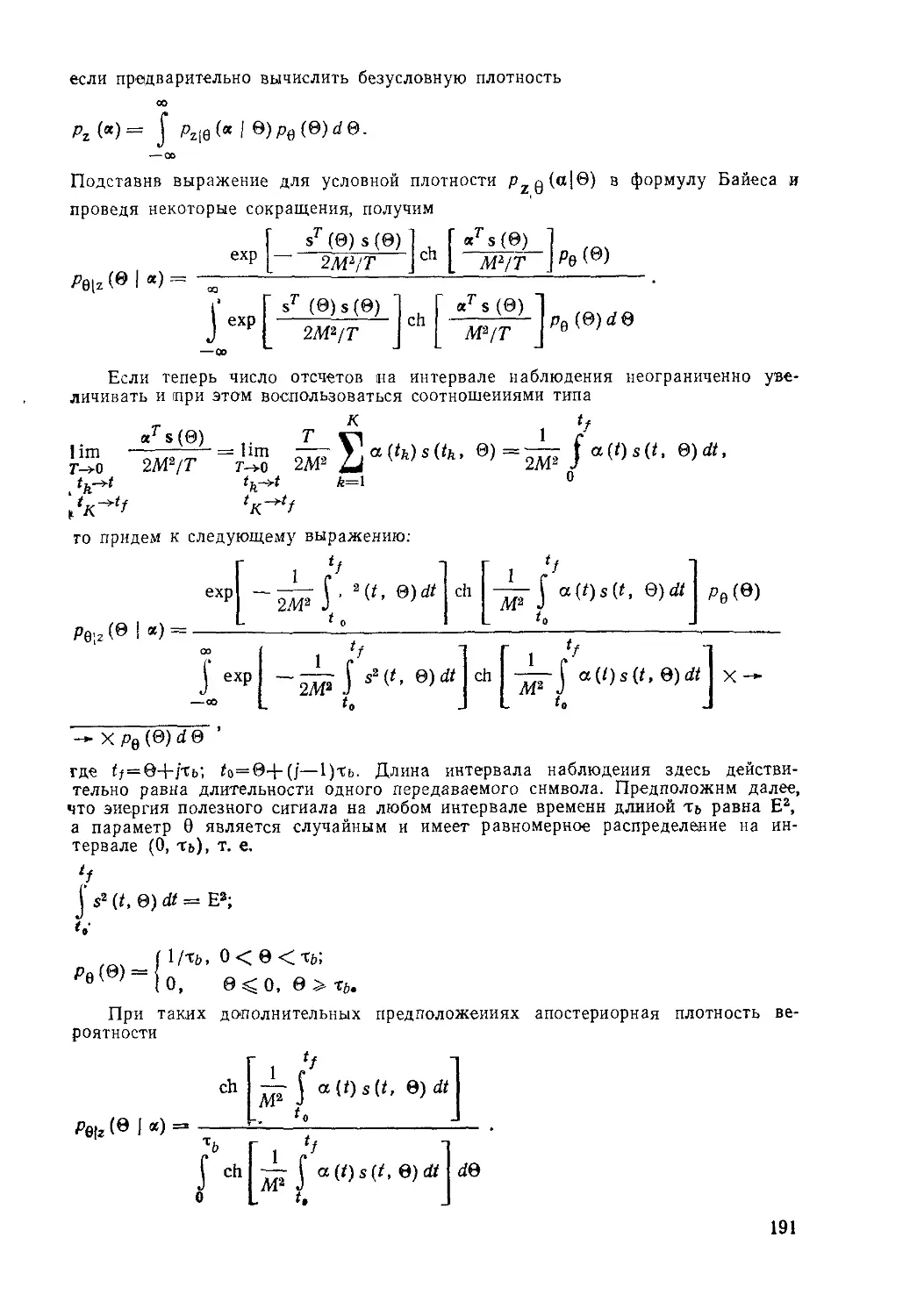

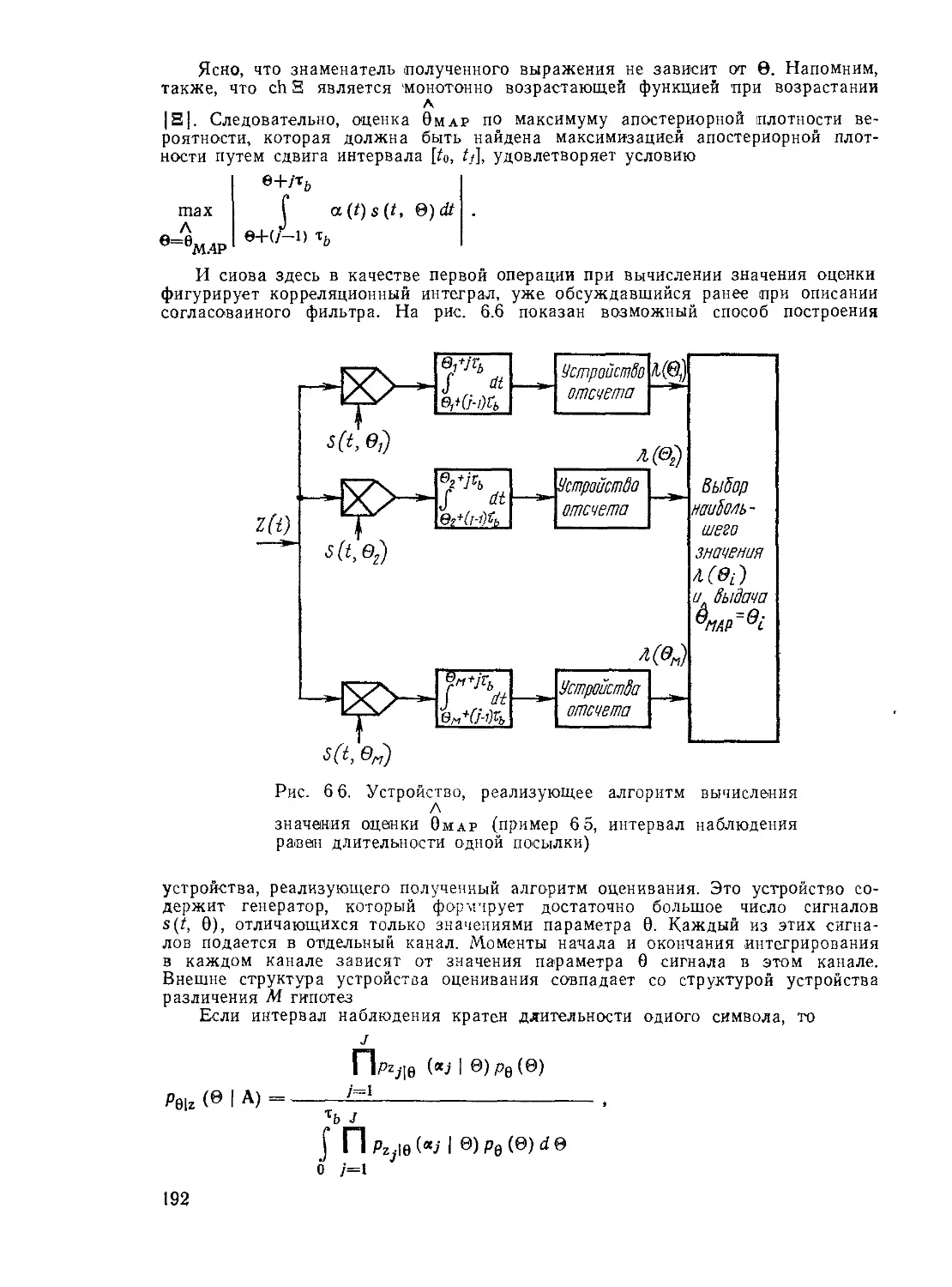

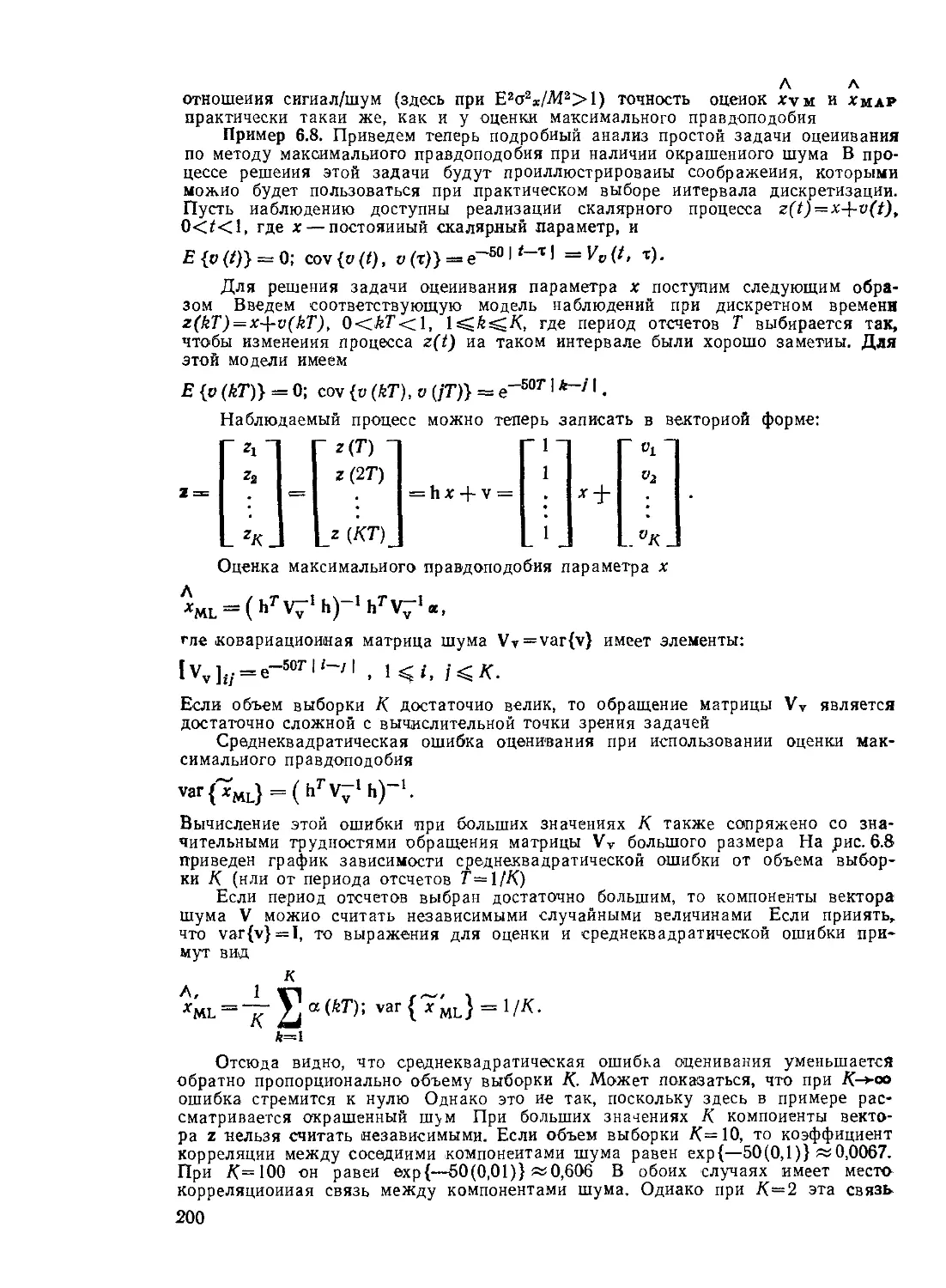

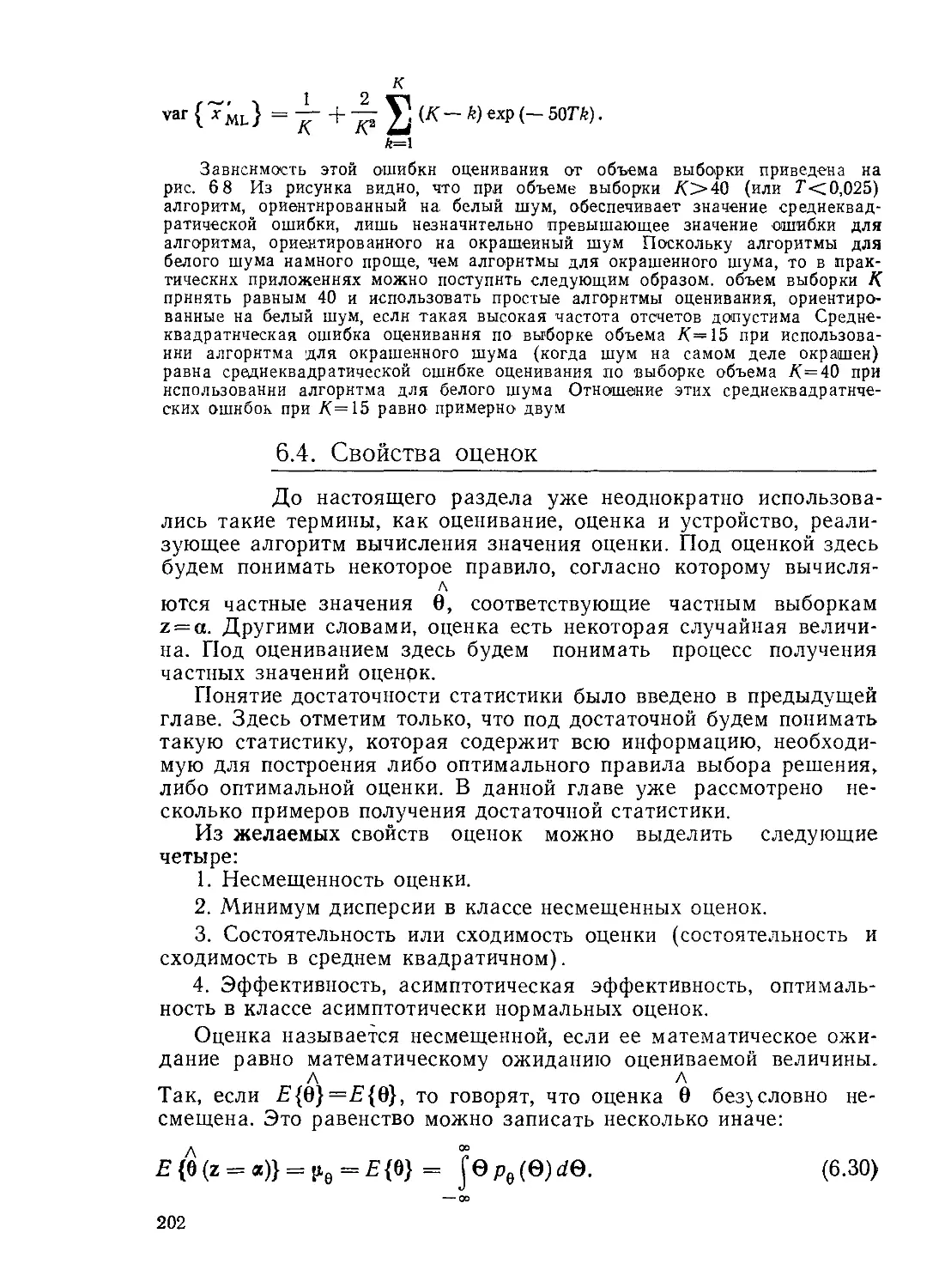

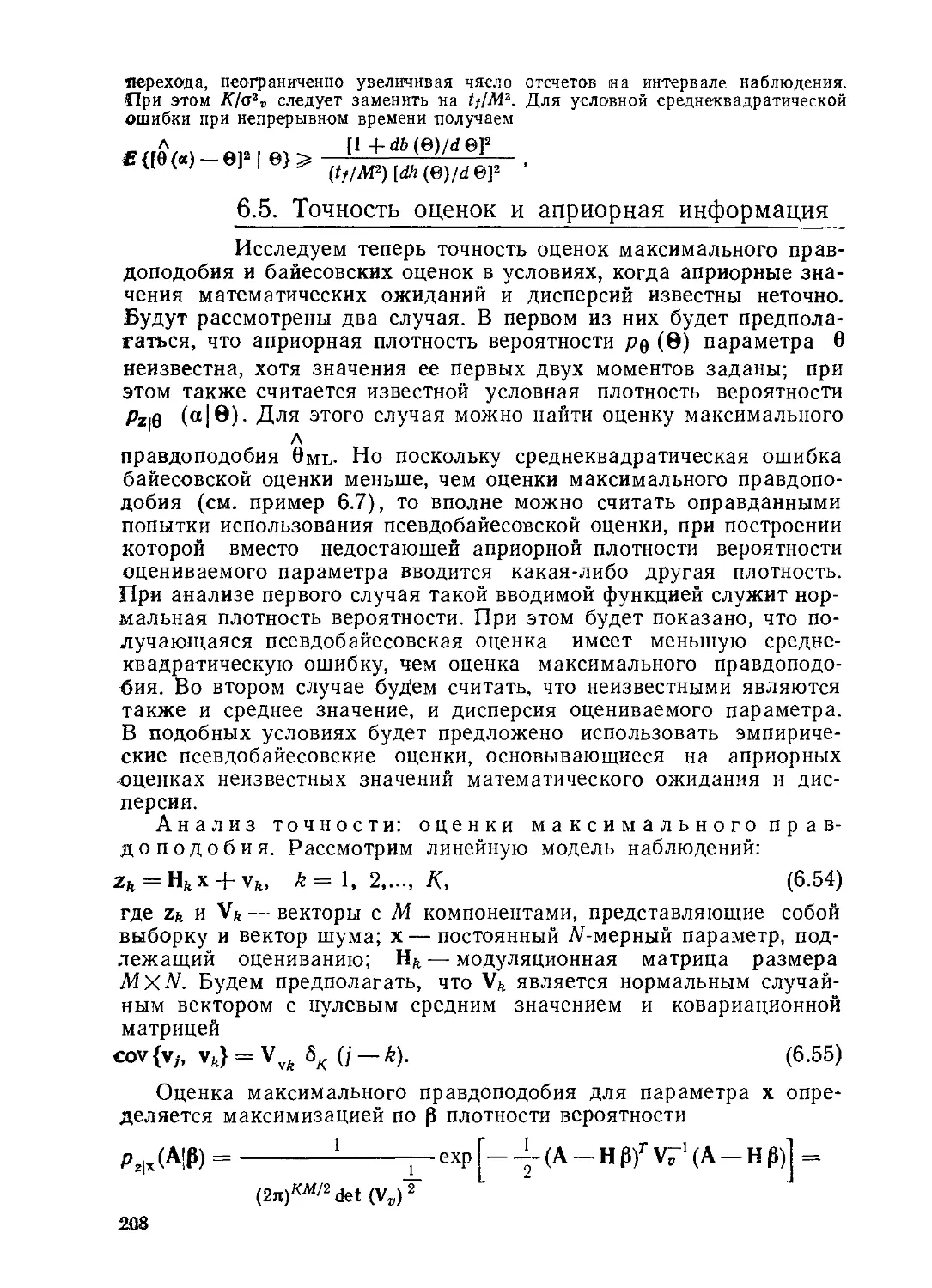

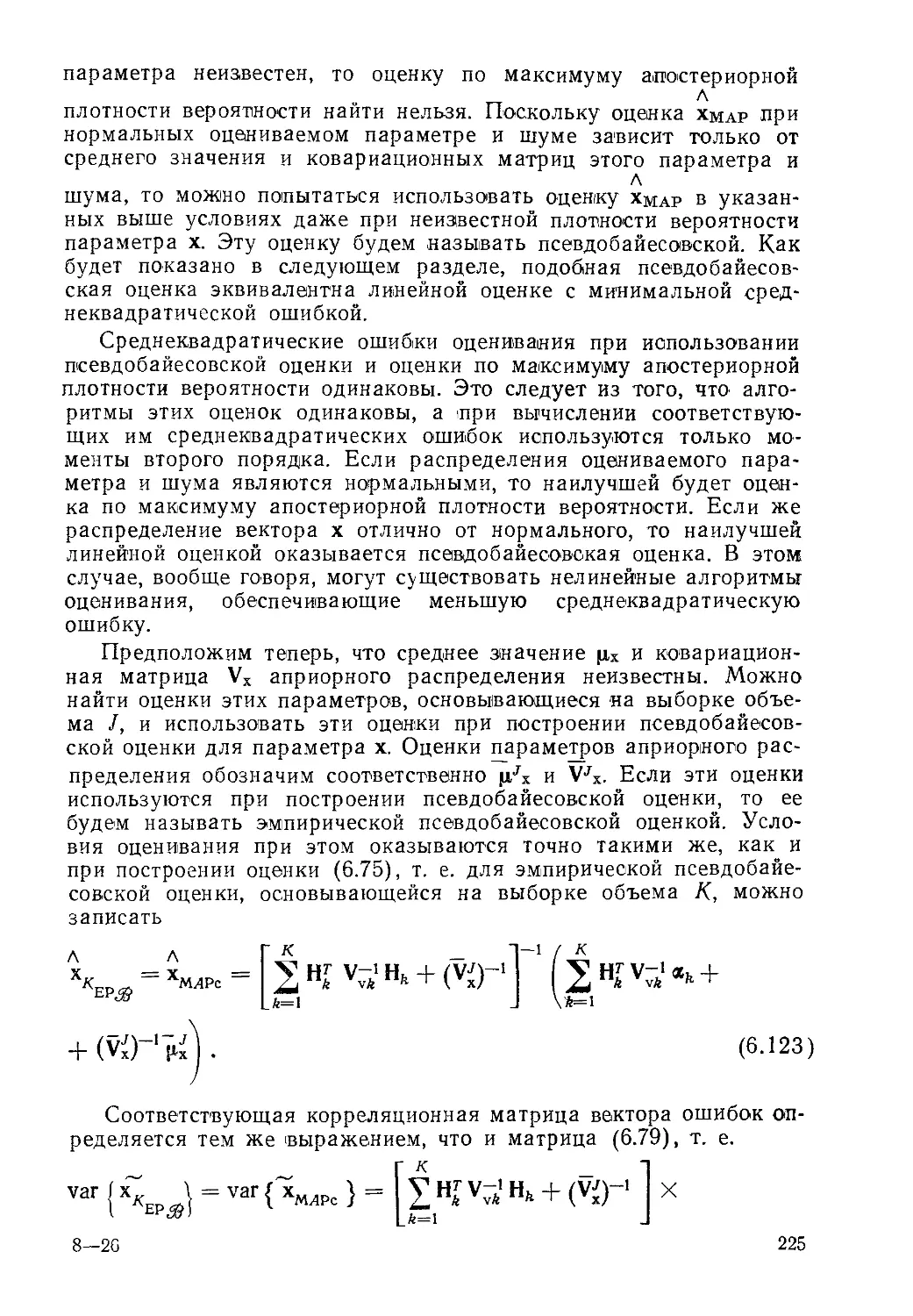

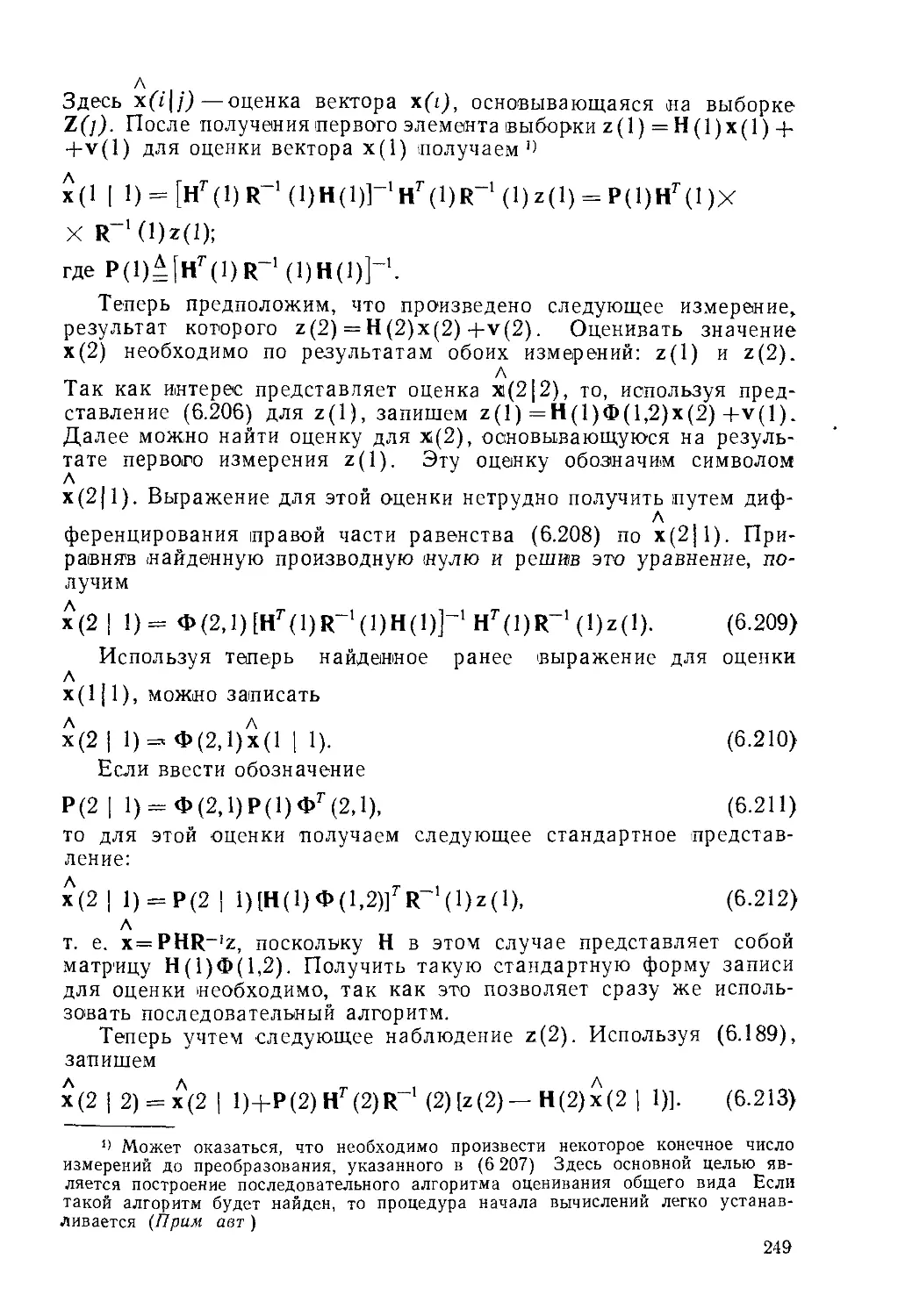

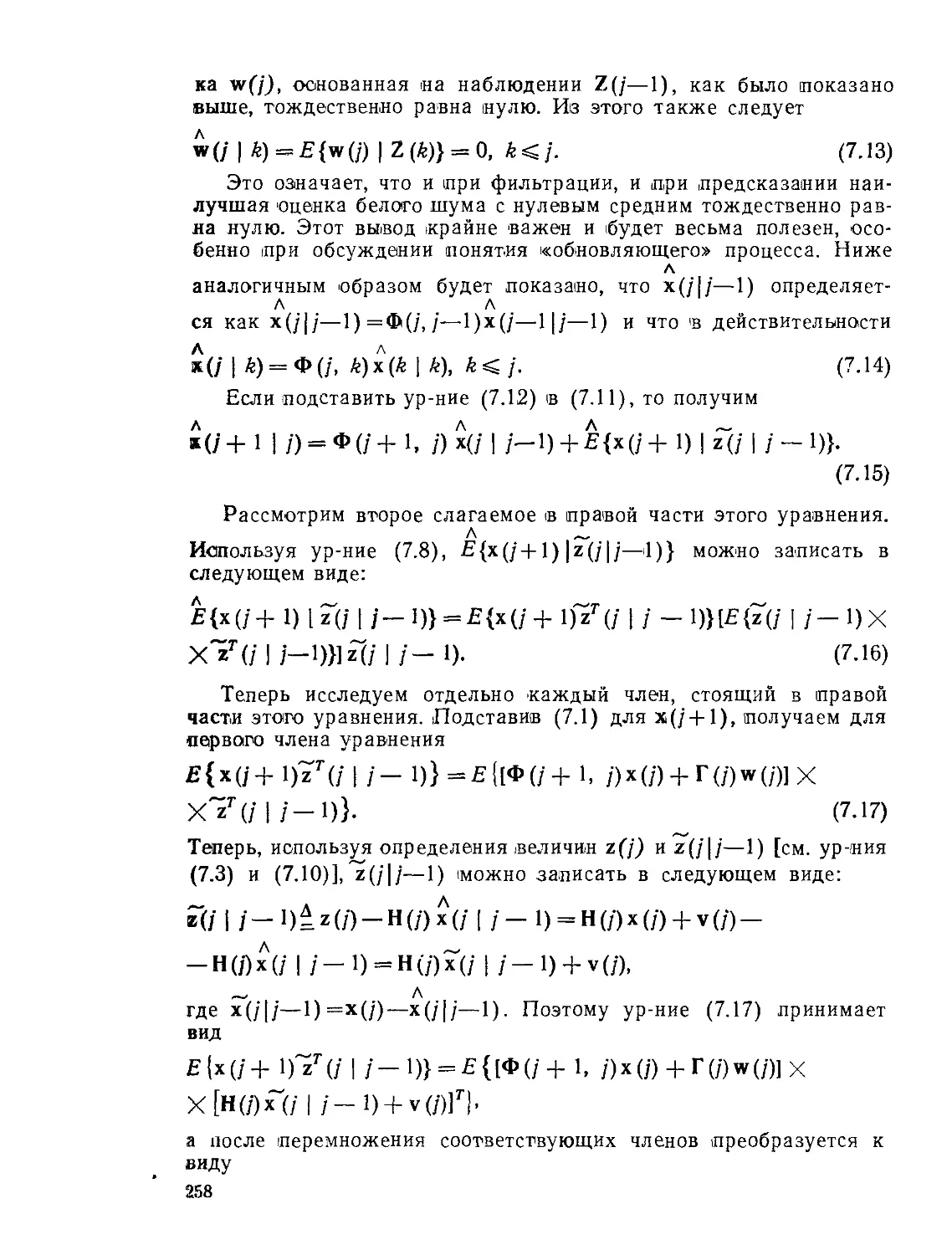

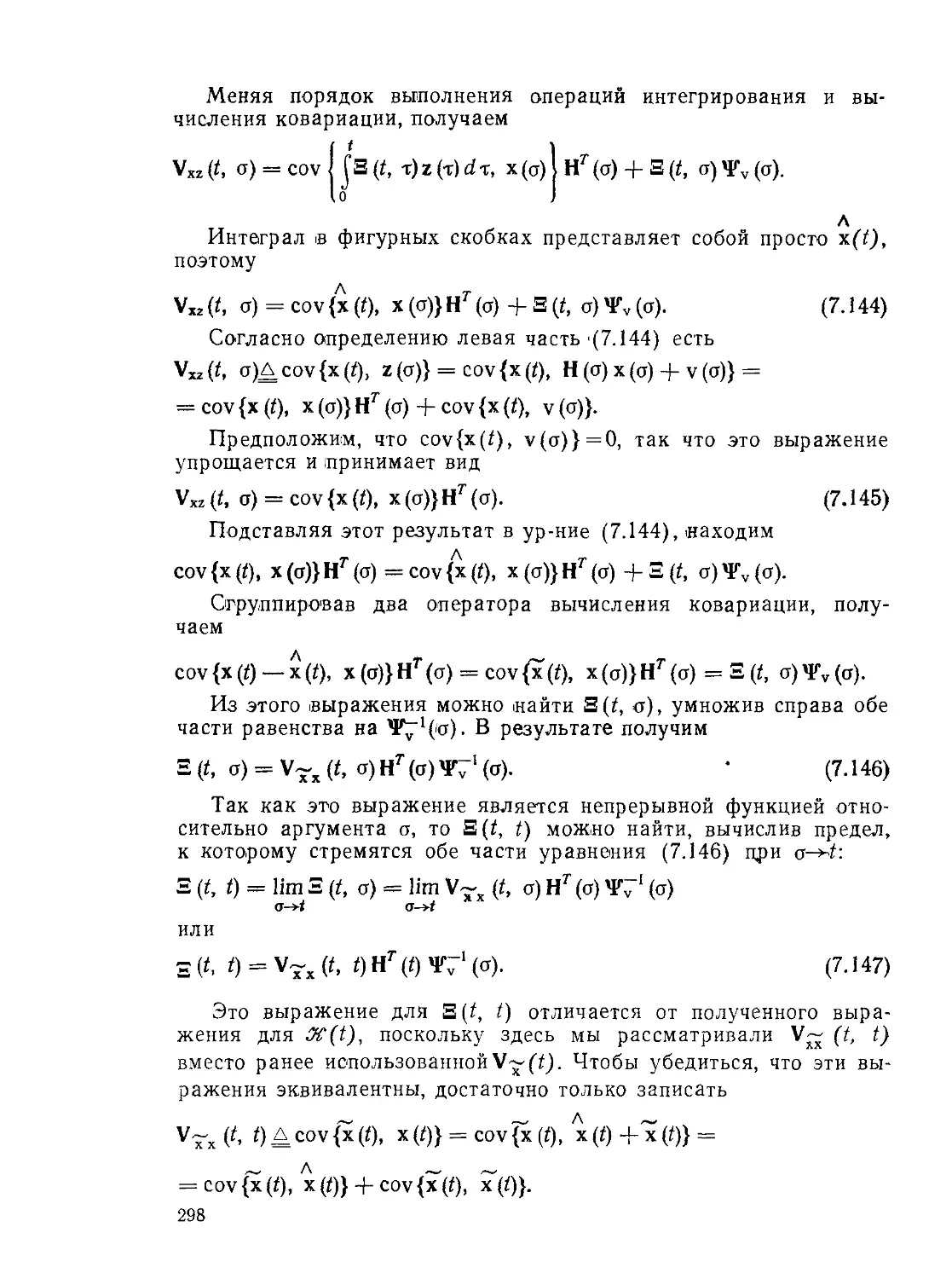

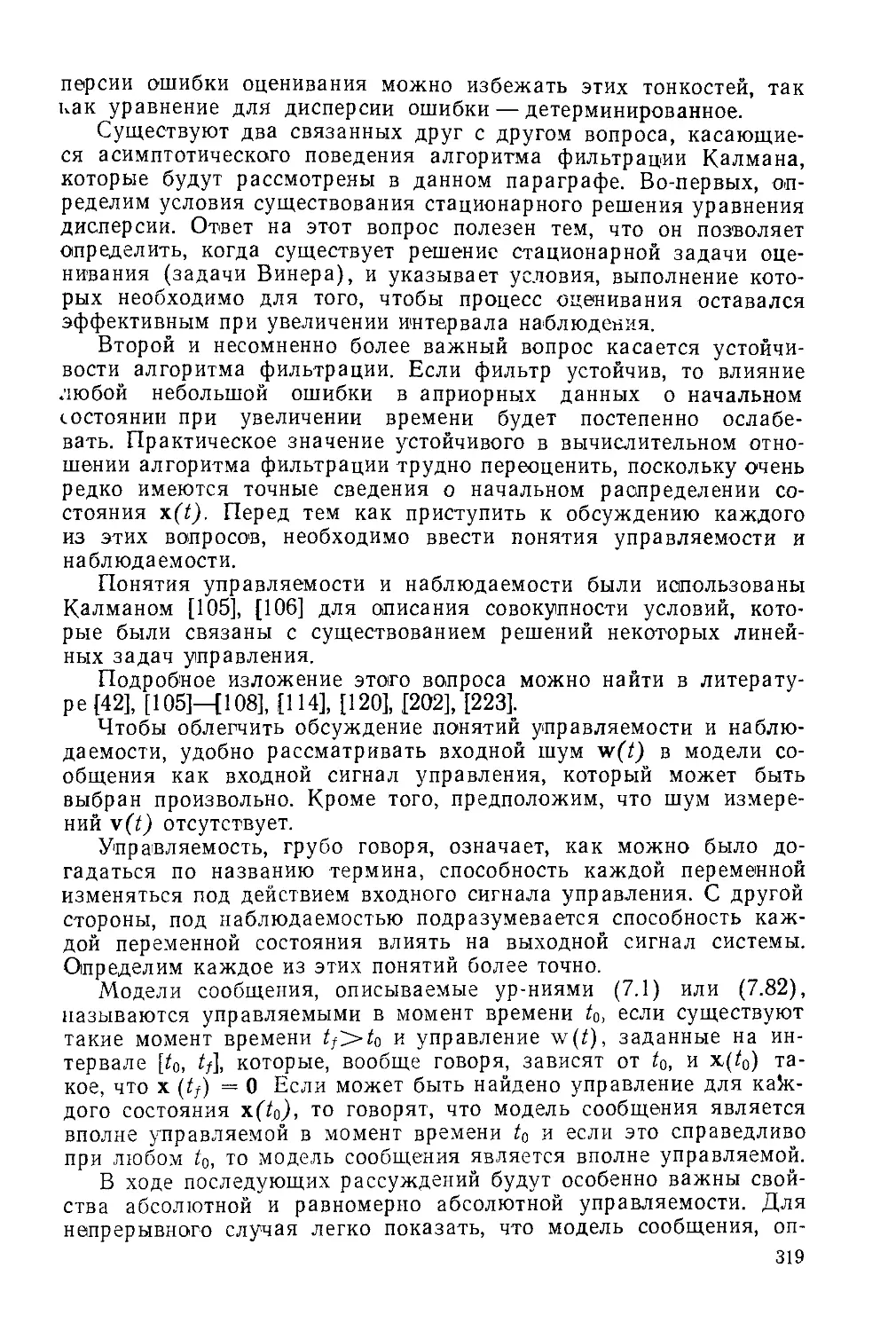

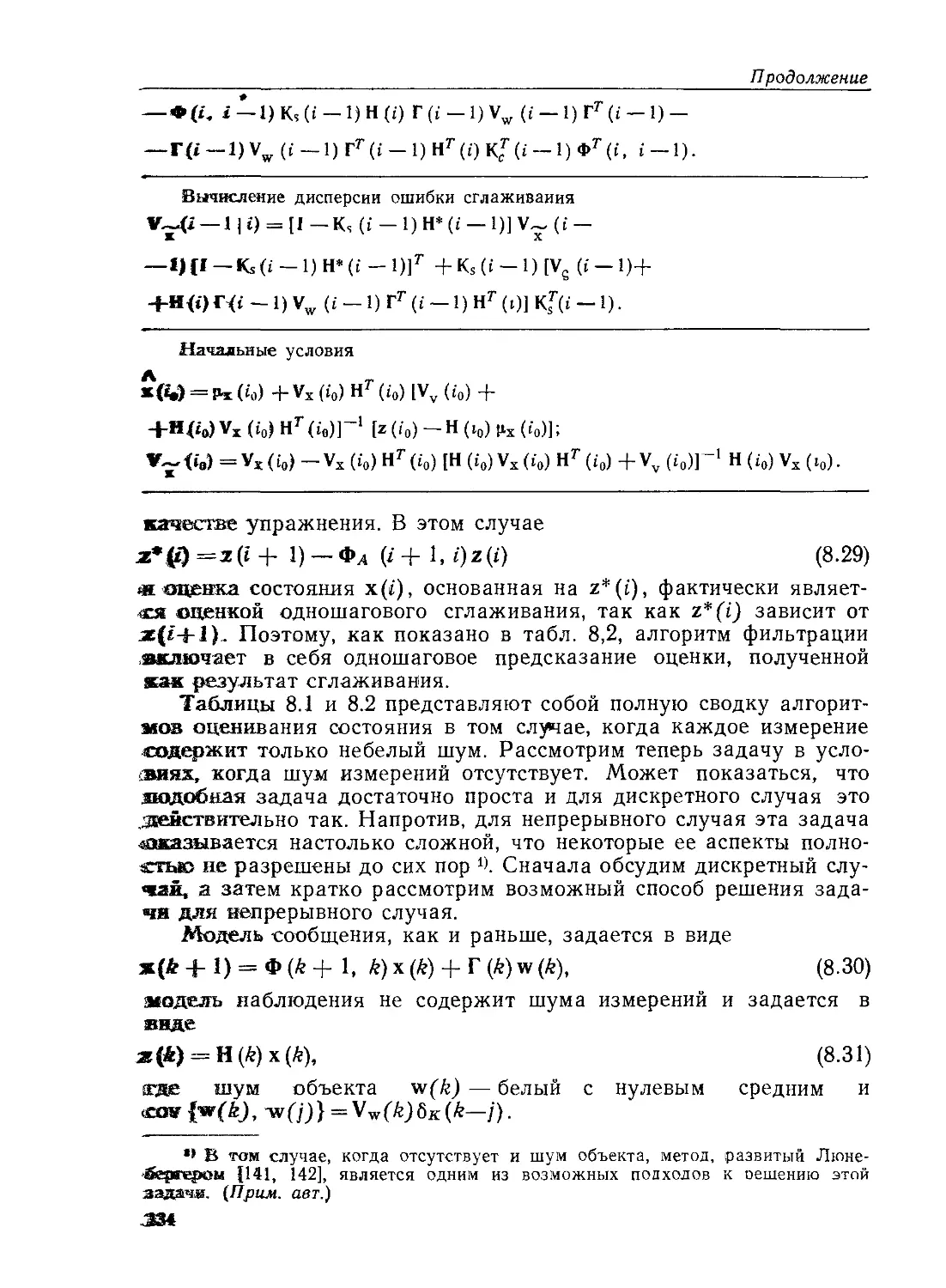

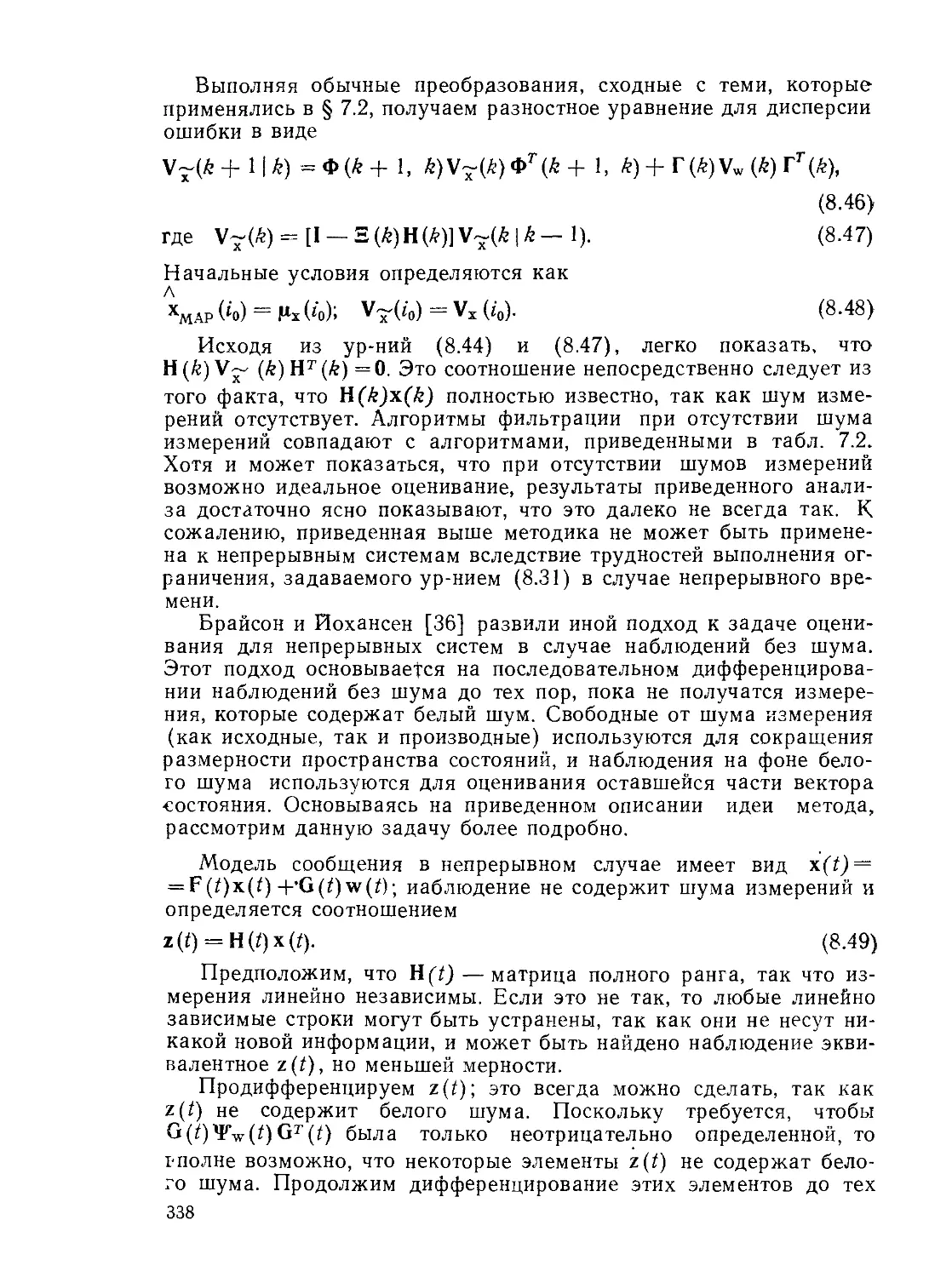

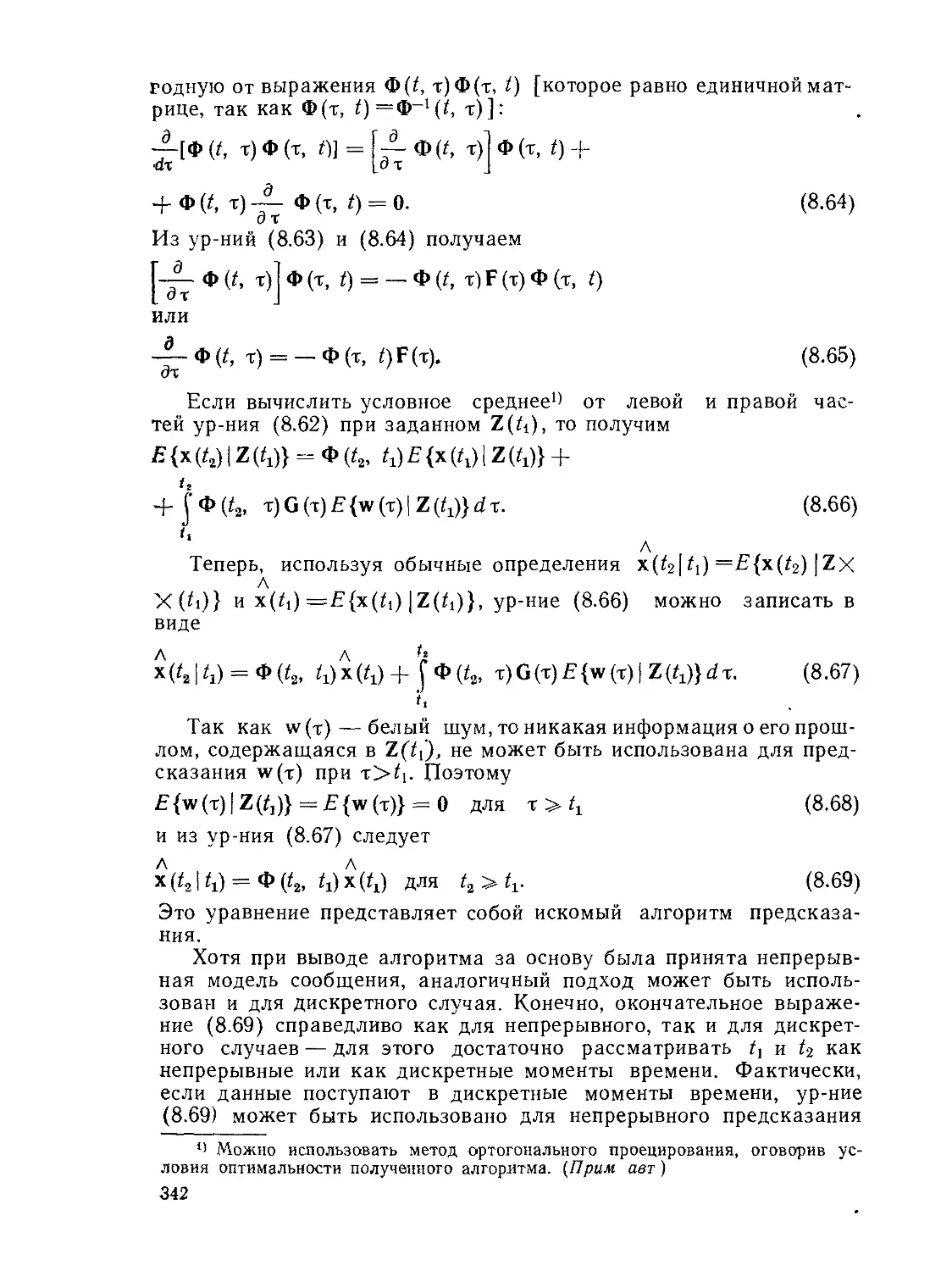

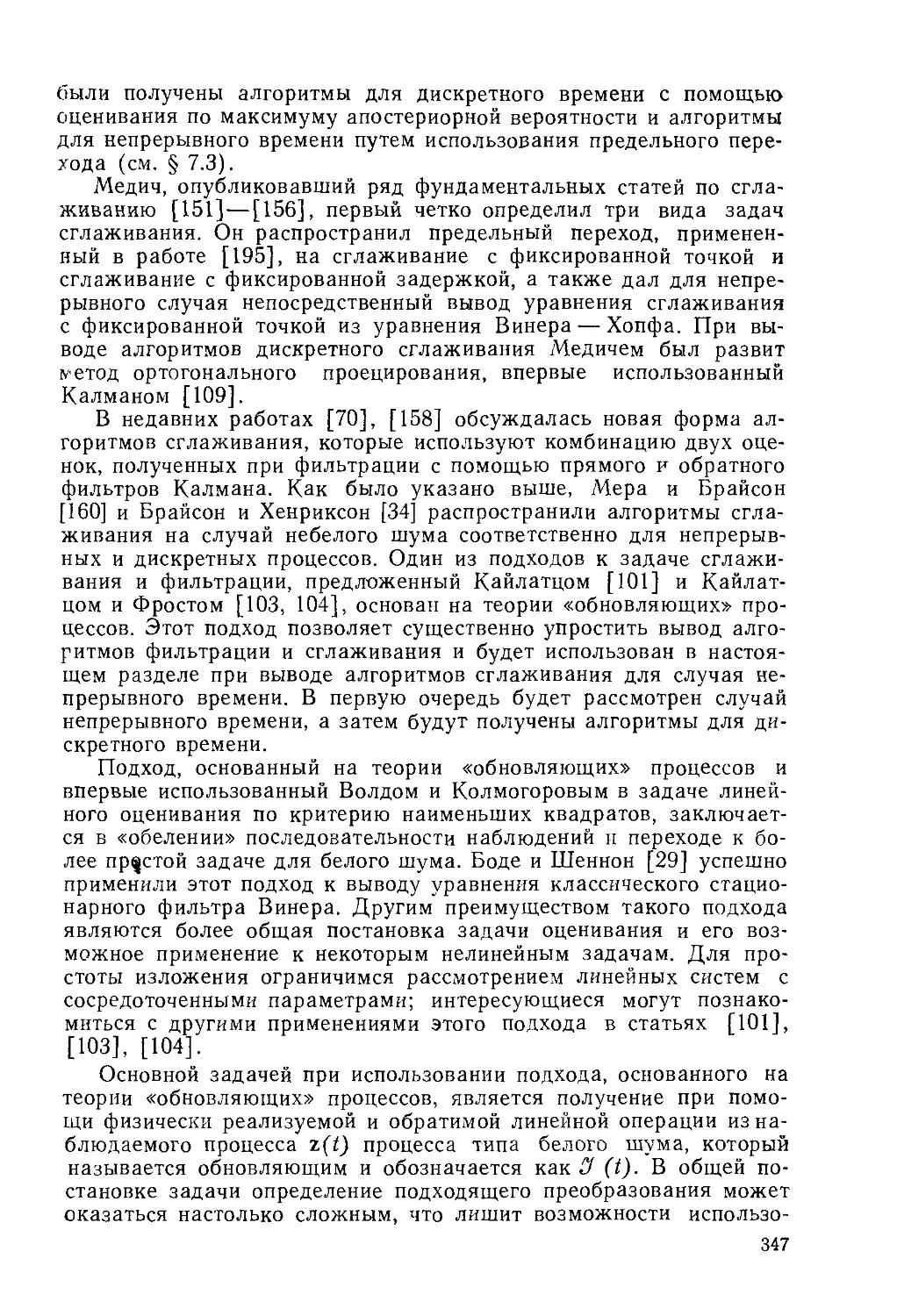

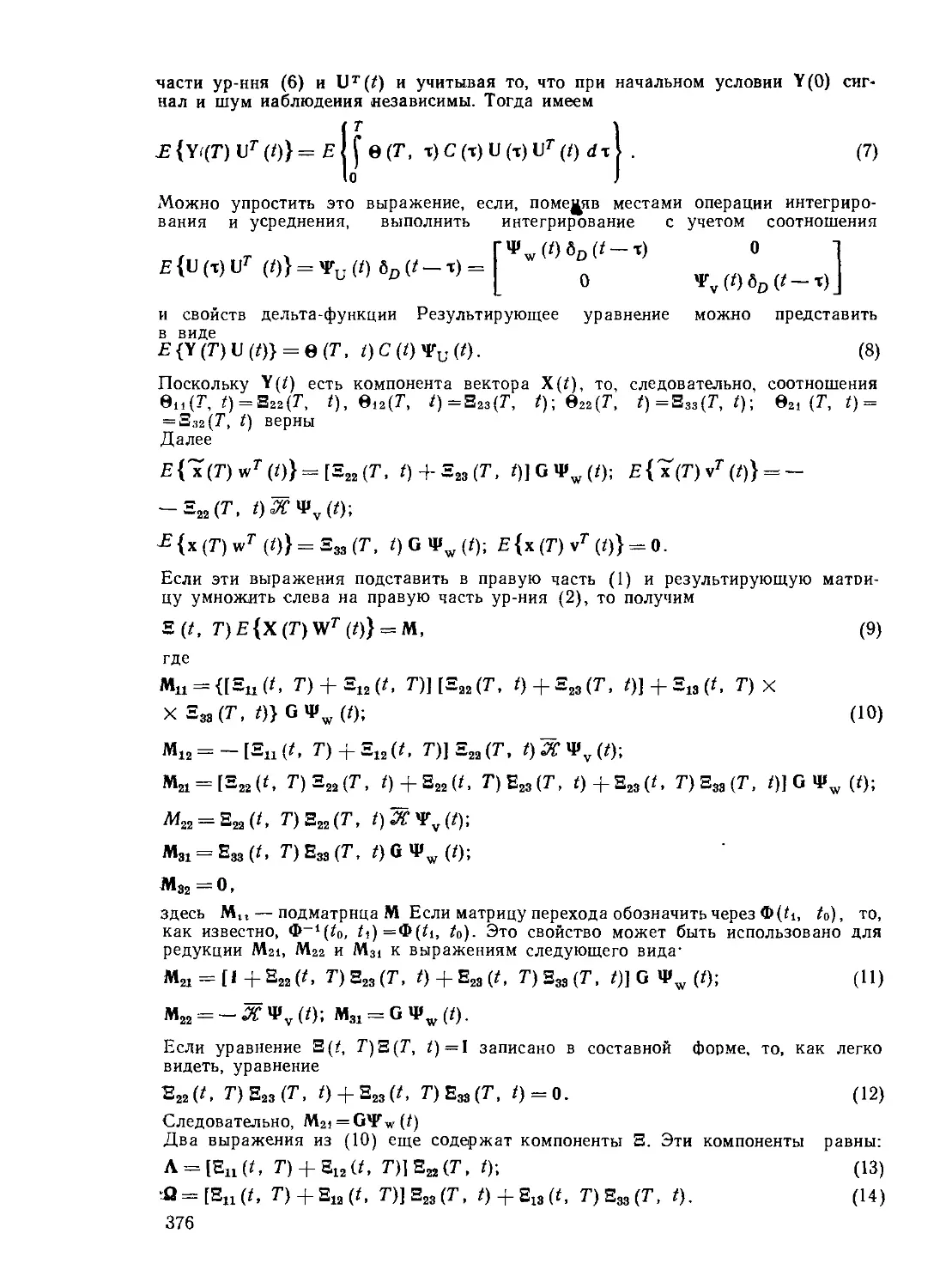

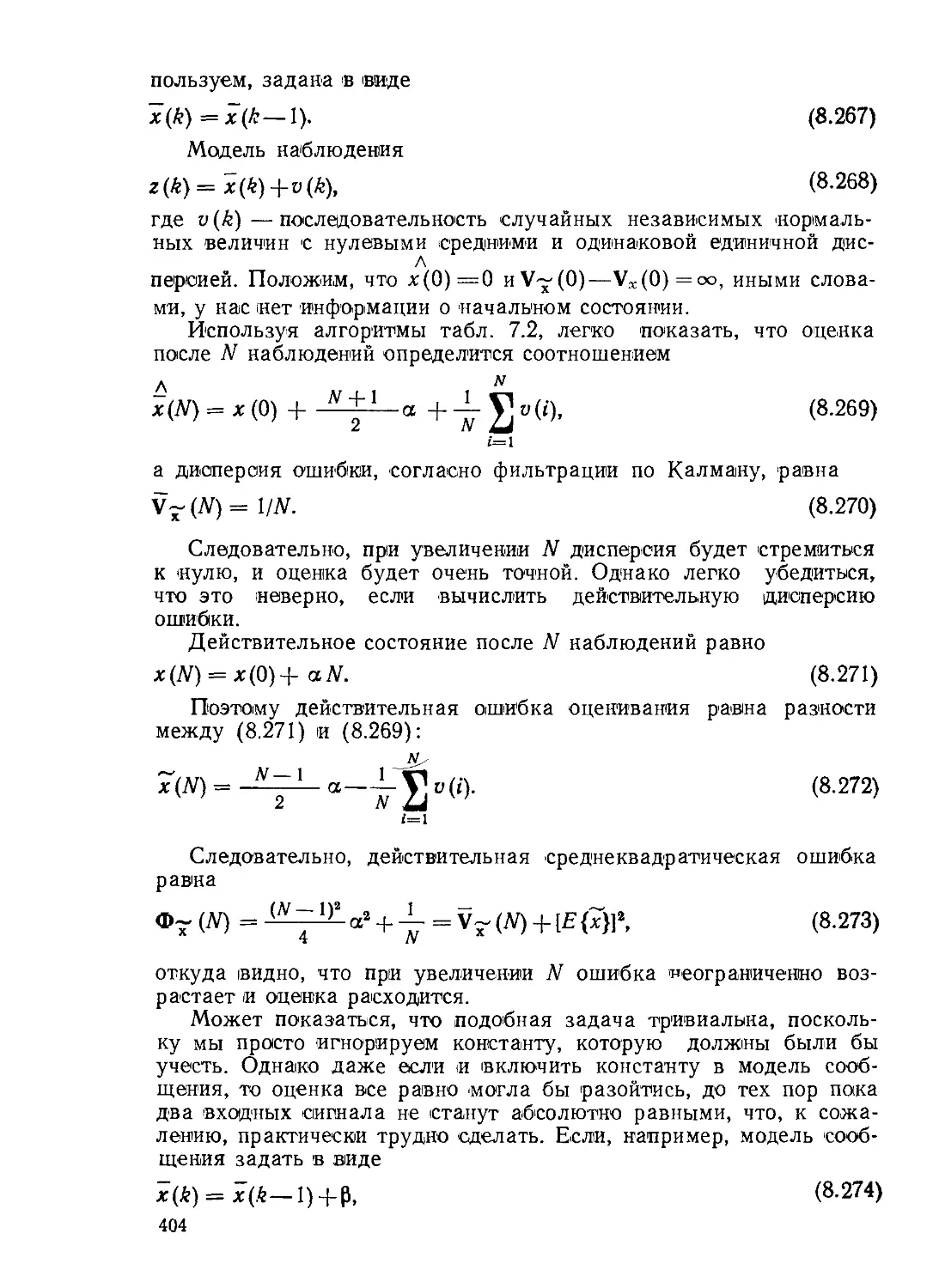

Графики приведенных выше функций даны >на рис. 2.1. Импульс-

ное распределение показывает, что дискретные распределения

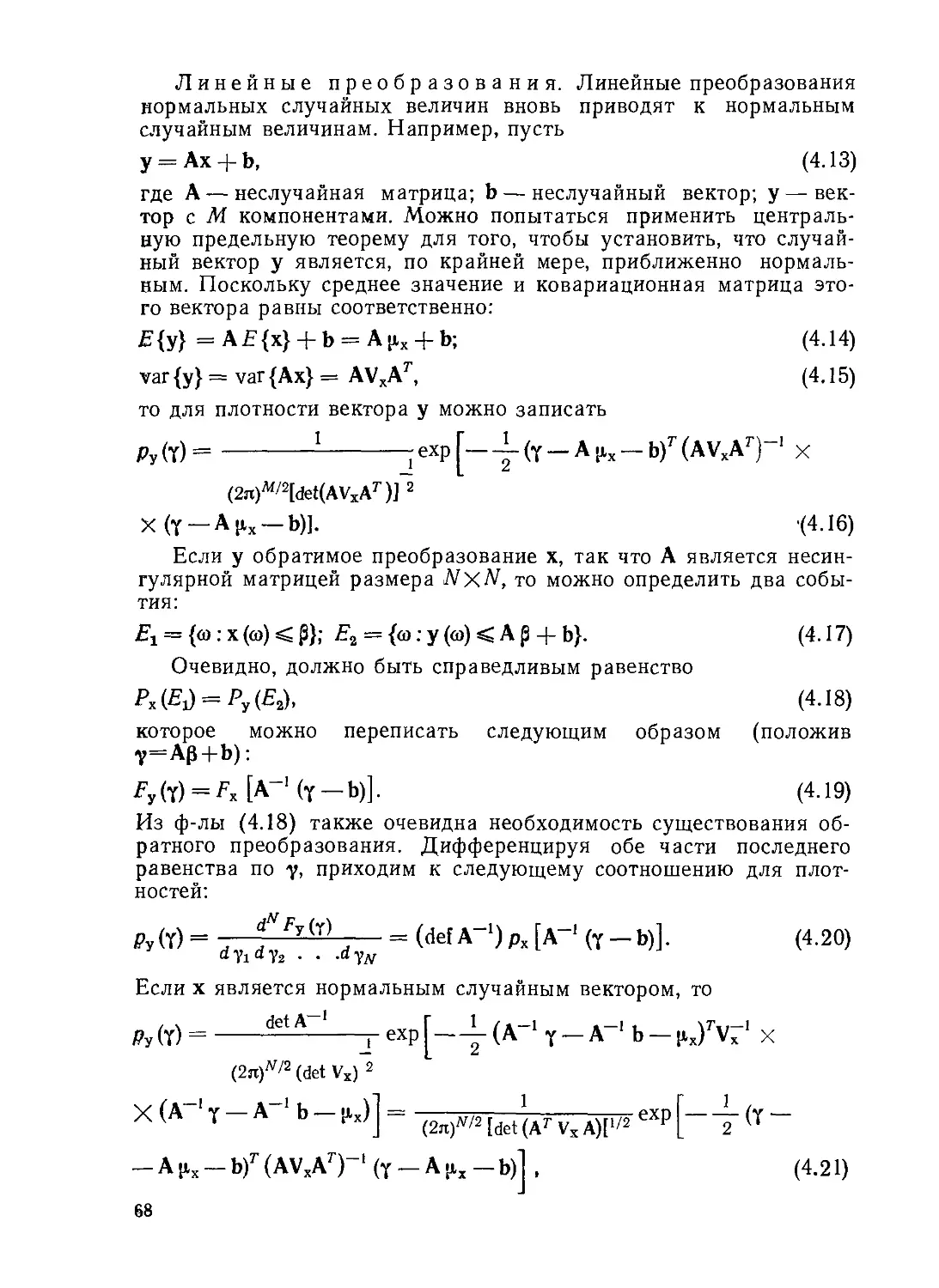

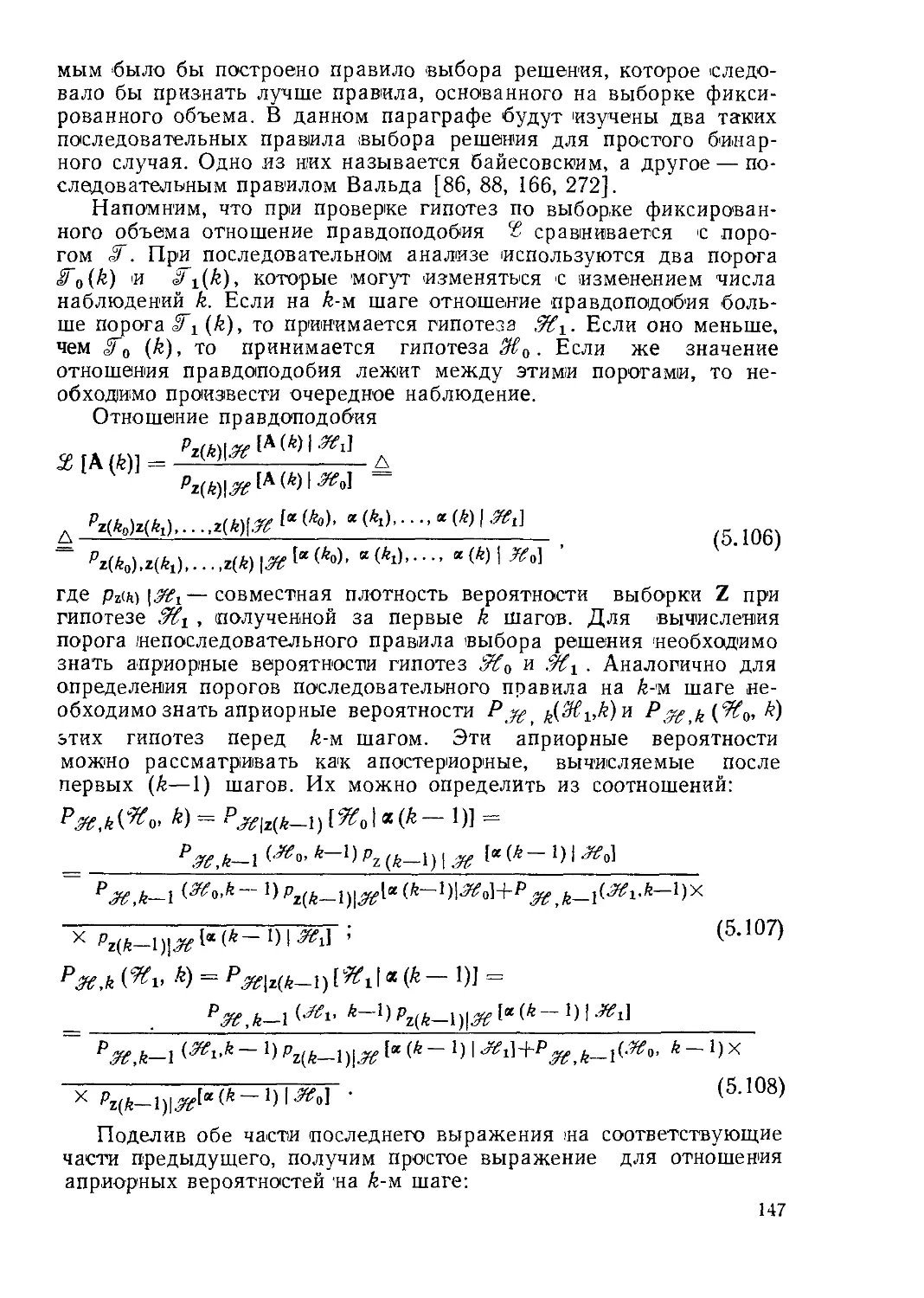

Рис. 2.1. Примеры непрерывных распределений вероятности:

а) равномерное; б) экспоненциальное; в) импульсное; г) релеевское;

д) гауссовское

*) Существует большое количество определений функций ошибок (erf), име-

ющих, по существу, одинаковый смысл. (Прим. авт.).

16

могут быть представлены как непрерывные с плотностями в виде

дельта-функций. Нормальное распределение является весьма важ-

ным, в чем мы сможем убедиться в дальнейшем.

Если имеются две случайные величины xt и х2, можно опреде-

лить двумерную функцию распределения вероятностей:

FXl, ж, (ai> а2) А.^х,. х, [ оо<хх<ах, —оо<^х2^а2], (2.24)

которая представляет собой вероятность того, что Xi меньше или

равно cxi и х2 меньше или равно а2. Чтобы связать эту функцию

с двумерной дискретной функцией распределения вероятностей,

следует лишь заметить, как и в одномерном случае, что мы опре-

деляем событие А, как событие, при котором —oo<xj^ai,

—оо<х2-^'сс2; другими (словами,

А = {®: — оо < хх (®) ах, — оо <z х2 (®) < а2};

РХ1, хг (ai, Pxt, х, (Л). (2.25)

Определим теперь событие Е следующим образом:

Е = {®: ax <zхх (®) ax + A «1. a2 <x2 (®) < a2 + A «2}; (2.26)

тогда вероятность наступления события Е

Pxlt х, (В) — Pxt, xs (-<4) PXl, х, (В) — РЖ1, Хг (С) PXt, Х,(Р), (2.27)

где события А, В, С и D определены как

А = {®: хх (®) < ах, х2 (®) < а2};

В — {®: хх (®) < ах, х2 (®) < а2 -ф Д а2};

С = {со: хх (со) <:ах + Д ах, х2(®)<а2}; (2.28)

D = {®: хх (®) < ах + Д ах, х2 (®) < а2 + Д а2}.

Обе части ф-лы (2.25) можно разделить на Да1Да2 и записать

через функции распределения:

pXl, xs (£) __ Fxt, X, (Ki + А «1. «2 + А «2) — FXi' Х1 (eg + A gx, a2) _

A ax A a2 A ax A a2

— a2 + Aa2)-FXi ^(ax, a2)

A ax A a2 ’ V • /

Переходя к пределу при Даг-И), получим

lim Р^- (£) = 1 Г ^^„^.(«i + Agn «2)

да^о A ax A а2 A ах L д а2

dFxt, х, (ai, аг)~

да2

• (2.30)

Если теперь определить предел при Даг->0, получим ^следующий

важный результат:

Рх^хЛ*1!’ a2)Alim

Да,->0

Aas->0

Рх'.хДЕ)

A ax A a2

dax <3a2

(2.31)

Выражение Px,. x, (ai, 02) представляет собой совместную функ-

цию плотности вероятности двух случайных величин. Из опреде-

ления события Е видно, что

17

PXl, x, [{и (и) < &L + Д а1( а2 < х2 (а) < а2 + Д а2}] =

= Д а± Д а2 pXl. х, (ар а2). (2.32)

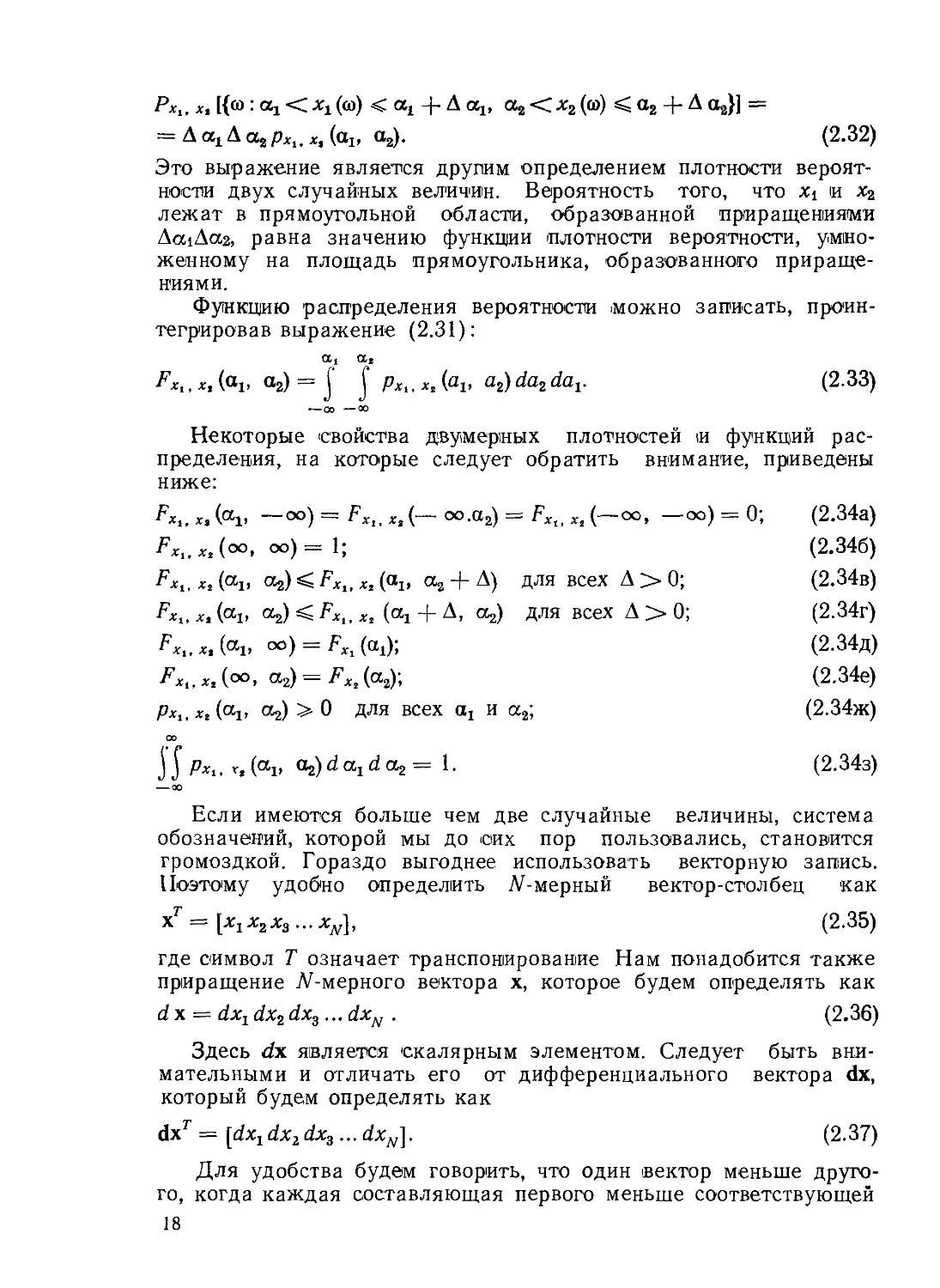

Это выражение является другим определением плотности вероят-

ности двух случайных величин. Вероятность того, что Xi и х2

лежат в прямоугольной области, образованной приращениями

Да1Да2, равна значению функции плотности вероятности, умно-

женному на площадь прямоугольника, образованного прираще-

ниями.

Функцию распределения вероятности можно записать, проин-

тегрировав выражение (2.31):

a2

FXt.xAai> a2) = j J Pxt,xAai> a2)da2dav

(2.33)

Некоторые свойства двумерных плотностей и функций рас-

пределения, на которые следует обратить внимание, приведены

ниже:

FXi, х, (“1, — оо) = Г Х1, Хг (— оо.а2) = FXlt Х2 (— оо, —оо) = 0; (2.34а)

Fxt.xA°°> оо)=1; (2.346)

х,(“1, ОгХ^.хЛар а2 + Д) для всех Д > 0; (2.34в)

Fx^xA^i, аа) ^Fxt, Хг («1 + д, а2) для всех Д > 0; (2.34г)

FXi,xAai> °o) = fXi(a1); (2.34д)

Fxl,xA<x< “2) = Лг(а2)’. (2.34е)

хг («1, «2) > 0 для всех aj и а2; (2.34ж)

00

j J pXl, Хг (an Oj) d d аг = 1. (2.34з)

--00

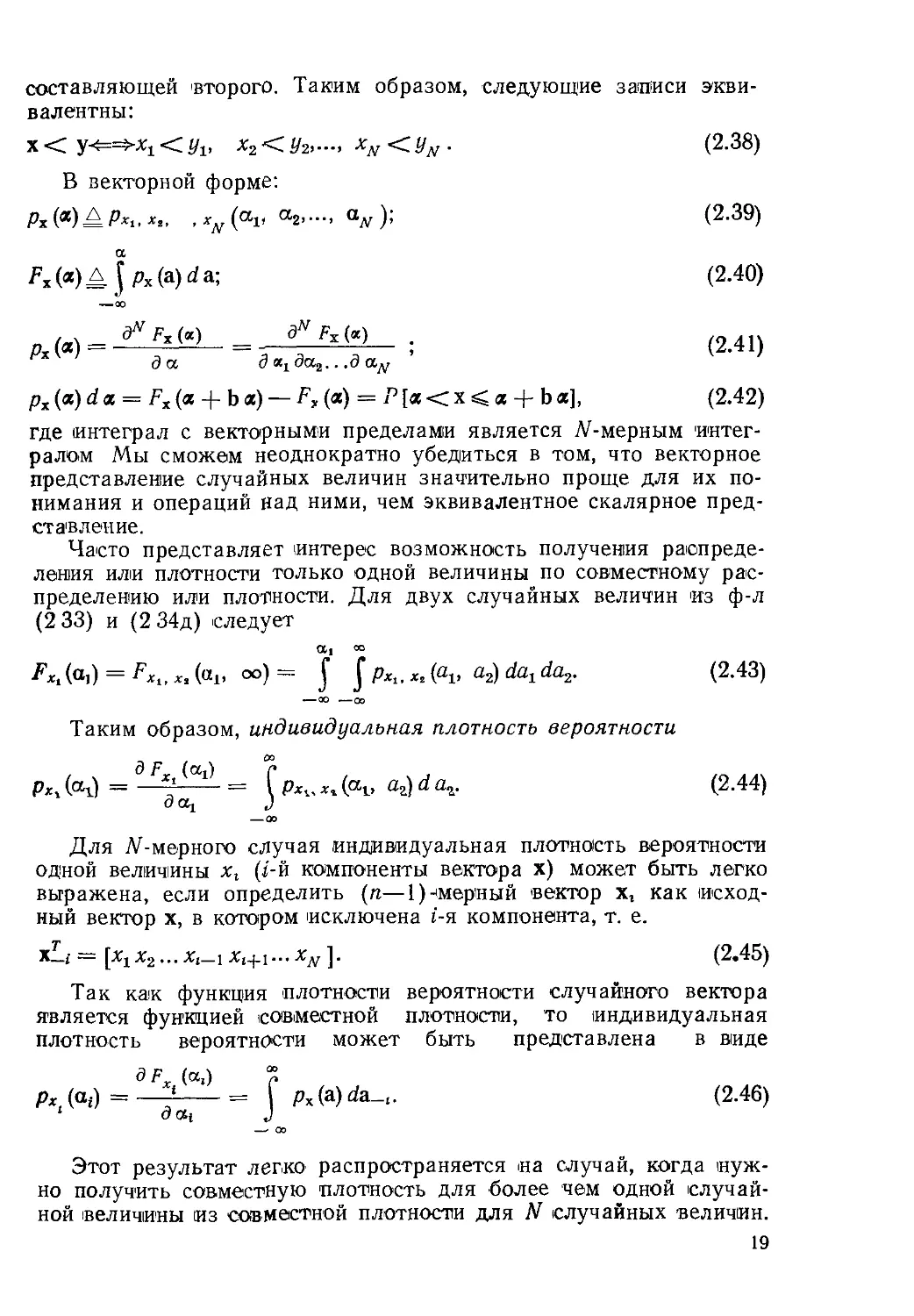

Если имеются больше чем две случайные величины, система

обозначений, которой мы до сих пор пользовались, становится

громоздкой. Гораздо выгоднее использовать векторную запись.

Поэтому удобно определить М-мерный вектор-столбец как

хг = [Xi х2 х3 ... х^, (2.35)

где символ Т означает транспонирование Нам понадобится также

приращение Димерного вектора х, которое будем определять как

d х = dxr dx2 dx3... dxN . (2.36)

Здесь dx является скалярным элементом. Следует быть вни-

мательными и отличать его от дифференциального вектора dx,

который будем определять как

dxr = [dxjdx2dx3... dxNJ. (2.37)

Для удобства будем говорить, что один вектор меньше друго-

го, когда каждая составляющая первого меньше соответствующей

18

составляющей 'второго. Таким образом, следующие записи экви-

валентны:

х z/j, x2<II/2>-"> ViV <~-^.v • (2.38)

В векторной форме:

Рх (®) = Рх1, хг, , (СТ1* СТ2>-"> “jV )> (2.39)

^х(«)А JPx(a)da; (2.40)

---00

р(Л) = = - ; (2.41)

и да дх1да2...дау

рх(а) d а = Fx(a -f- b а) — F„ («) = Р [а < х < а + Ь а], (2.42)

где интеграл с векторными пределами является М-мерным интег-

ралом Мы сможем неоднократно убедиться в том, что векторное

представление случайных величин значительно проще для их по-

нимания и операций над ними, чем эквивалентное скалярное пред-

ставление.

Часто представляет интерес возможность получения распреде-

ления или плотности только одной величины по совместному рас-

пределению или плотности. Для двух случайных величин из ф-л

(2 33) и (2 34д) следует

^x,(ai) = *.(«!. о°) = J a^darda2. (2.43)

Таким образом, индивидуальная плотность вероятности

э °0

Рх, (<Ч) = - = f Рх„ X, (<Ч> d аг. (2.44)

О CCj J

—оо

Для М-мерного случая индивидуальная плотность вероятности

одной величины хг (/-й компоненты вектора х) может быть легко

выражена, если определить (п—1)-(мерный вектор хг как исход-

ный вектор х, в котором исключена i-я компонента, т. е.

х—i — (х^ х2... х(—1 х1+1... Ху ]. (2.45)

Так как функция плотности вероятности случайного вектора

является функцией совместной плотности, то индивидуальная

плотность вероятности может быть представлена в виде

3F (a,)

P*A<*i)=—;--------= px(a)da_,. (2.46)

‘ <?at J

Этот результат легко распространяется на случай, когда нуж-

но получить совместную плотность для более чем одной случай-

ной величины из совместной плотности для N (случайных величин.

19

Во многих случаях для определения непрерывных случайных

величин нужно знать условные функции распределения и плот-

ности. Начнем с двух случайных скалярных величин х и у, а за-

тем распространим результат на векторные случайные величины

X и у.

Определим два события Л и В:

Л = {ю:— оо<х(й)<а}, В = {со : Р1 <у (®) < Р2}. (2-47)

Тогда согласно (2.10) вероятность того, что х больше, чем —оо,

но меньше или равен а при условии, что значение у лежит в ин-

тервале от —Pi до р2, равна

(Л/В) = Рх,у (Л, В)/Р, (В). (2.48)

Используя функции плотностей вероятности, можно это выра-

жение представить в виде

а р2

[ [ Рх j/ 46 da

Рх\и (Л|В) = . (2.49)

[ Ру (6) 46

Pt

Так'как вероятность/Того, что —оо<х.^’а при условии, что

Р1<г/^Р2, уже получена, то теперь нужно получить функцию рас-

пределения х при условии, что у задано. Действительно, при

Pi=p2=p мы должны получить функцию распределения. Однако

возникают некоторые трудности, так как знаменатель в правой

части (2.49) будет равен нулю почти во всех случаях, когда

Рг— Pi. Если положить р2—pi=Ap, то

а ₽4-Д р а

f рх,у{а, b)dbda ж Др у(а, $)da\

— ОО р — <»

Р+ДР

[ М^ЛжДррДр).

3

Таким образом, при р2—>-pi=p условная функция распределе-

ния вероятности для х при условии £/= р имеет вид

Exit,(а|Р) = limРХ|ДЛ|В) = ( f Px.yifl, $)da |/рД₽). (2.50)

др—>0 \ * /

\—оо /

Условная плотность вероятности определяется как производ-

ная от условной функции распределения:

0 . (а I— аГл/и|Р) - р^(а’ р) (2 51)

PxiMcqp)- да - • (2.01)

20

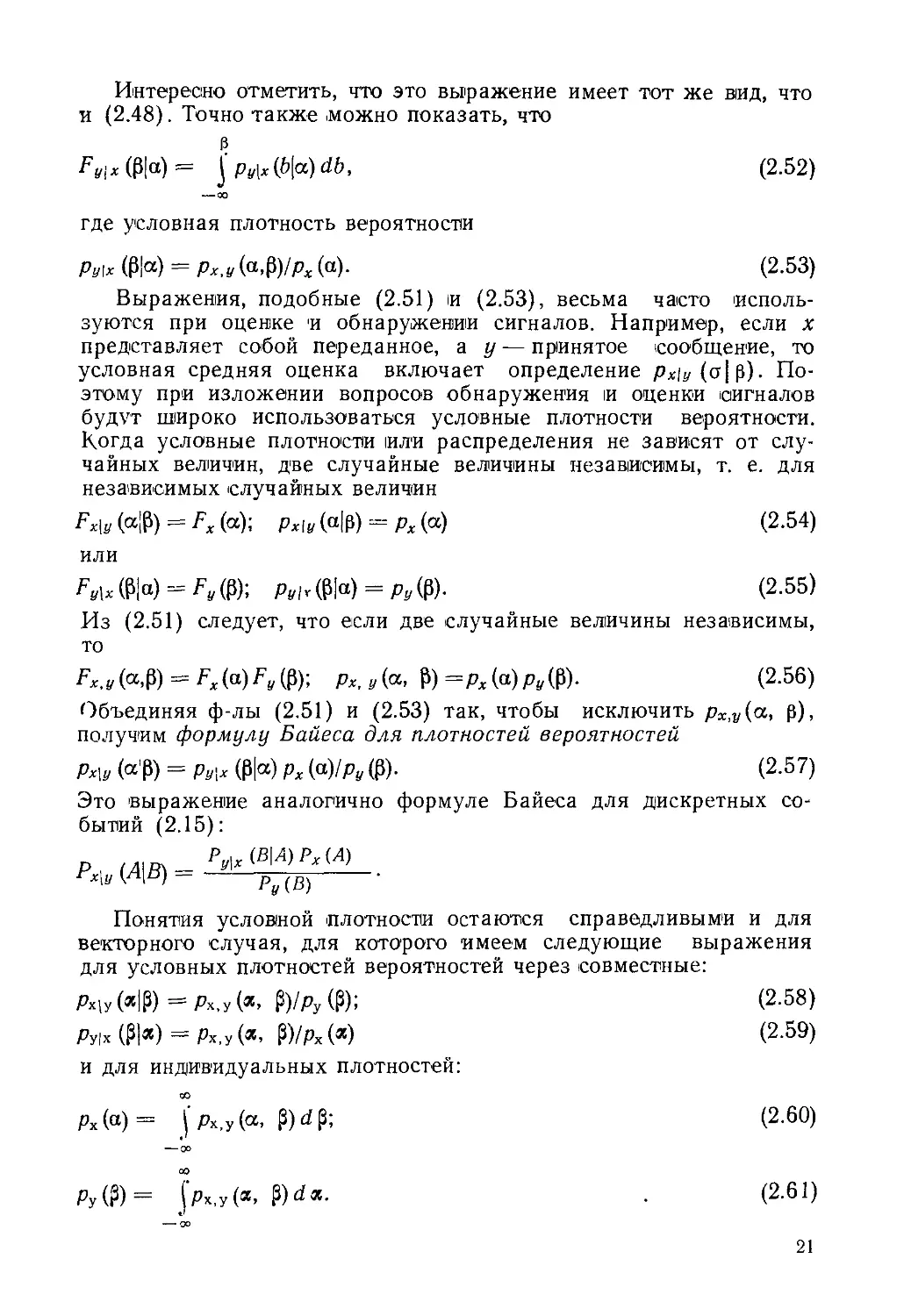

Интересно отметить, что это выражение имеет тот же вид, что

и (2.48). Точно также .можно показать, что

3

Fvl * (₽1“) = j Ру\* (6|а) db, (2.52)

-00

где условная плотность вероятности

Ру\х (₽|а) = рх,у (а$урх (а). (2.53)

Выражения, подобные (2.51) и (2.53), весьма часто исполь-

зуются при оценке и обнаружении сигналов. Например, если х

представляет собой переданное, а у — принятое сообщение, то

условная средняя оценка включает определение рх\у (ст|р). По-

этому при изложении вопросов обнаружения и оценки сигналов

будут широко использоваться условные плотности вероятности.

Когда условные плотности или распределения не зависят от слу-

чайных величин, две случайные величины независимы, т. е. для

независимых случайных величин

Fx\y (а|Р) = Fx (а); рх[у (а|р) = рх (а) (2.54)

или

Fу\* (₽|а) = Fy (₽); Pylr (₽|а) = Ру (₽)• (2.55)

Из (2.51) следует, что если две случайные величины независимы,

то

Fx.y(a$) = «Ж Рх, у (а, Р) =рх(а)рДР). (2.56)

Объединяя ф-лы (2.51) и (2.53) так, чтобы исключить рх,у(а, р),

получим формулу Байеса для плотностей вероятностей

Рх\у (а'Р) = Ру\х ф|а) рх (а)/ру (₽). (2.57)

Это выражение аналогично формуле Байеса для дискретных со-

бытий (2.15):

р , (А\В} - Р^(ВИ)РИЛ)

^Х\у И|В) pv

Понятия условной плотности остаются справедливыми и для

векторного случая, для которого имеем следующие выражения

для условных плотностей вероятностей через совместные:

Рх\у(«|Р) = рх,у(«> ₽)/ру(₽); (2.58)

Ру,'х (Р|«) = Рх.у (Я, ₽)/Рх («) (2‘59)

и для индивидуальных плотностей:

Рх (а) = ( Рх.у (а, Р) d Р; (2.60)

--ОО

РУ(Р) = jpx,y(a, ₽)d«. . (2.61)

21

Для двух независимых случайных векторов хну имеем:

^х|у (я|₽) = Fx (я); Рх|У («|₽) = Рх («); (2.62)

Fy|x (Р|я) = F? (Р); ру|х (Р|Я) = Ру (Р); (2.63)

Fx.y(a,p) = Fx(«)Fy(P); рх.у(я, ₽) = рх (я) ру (₽). (2.64)

Формулу Байеса можно также непосредственно применить к

векторному случаю, и она имеет такой же вид, как и (2.57):

Рх|у (я|₽) = ру,х (Р|я) рх (я)/ру (Р). (2.65)

Во многих случаях в теории оценивания и ее применении в связи

и управлении необходимо вычислить плотность вероятности функ-

ции случайных величин Обратим теперь внимание на эту важ-

ную задачу.

2.4. Алгебраические действия над случайными

величинами

Задачи теории оценивания довольно часто приводят

к необходимости вычисления результатов комбинации двух или

более случайных величин, а также линейных или нелинейных

операций над одной или более случайными величинами. В этом

параграфе последуют комбинации двух или более случайных ве-

личин и результаты алгебраических действий над ними.

Начнем с простого случая линейного преобразования скаляр-

ной случайной величины х:

у = ах -\-Ь, 'а > 0, (2.66)

где а я b известные постоянные величины. Известна также плот-

ность вероятности рх(а) и требуется получить плотность вероят-

ности ру(а). Определим событие Л = {со: x(<o)'^ai} и событие

В = {ico : z/((o)-^'a.ai + b}. Поскольку оба события относятся к од-

ному и тому же исходу, ясно, что

РДЛ) = РДВ) и Fx(a1) = Fv(aa1 + 6). (2.67)

Если обозначить y—aat + b , то

F,(y) = Fx(^). (2.68)

Искомая функция плотности вероятности новой величины у полу-

чается при дифференцировании этого выражения по у:

Ру (у) = — Рх для а > 0. (2.69)

Если а отрицательна, то необходимо переопределить события

А и В так, чтобы А = {<в : x(<o)-^‘ai} и В = {со : у (со) ^аа1+Ь}.

Так же, как было получено выражение (2.68), находим

рДу) =-----Для а<0. (2.70)

а \ а /

22

Объединяя (2.69) и (2.70), получим ру (у) = уу-рх

Несколько более сложное преобразование получается при про-

хождении случайной величины х с известной функцией плотности

вероятности через устройство с квадратичной характеристикой.

Пусть

У = х2. (2.71)

Преобразование от данного х к значению у однозначное. Однако

обратное преобразование неоднозначно. -

соответствуют два значения х= ±Уу.

Таким образом, для случайной

Данному значению у

величины у событие

В= {и : г/(со) р} при р>0 соответствует событию Л = : — р2 С

<х((о)С02), так что имеем РХ(А)=РУ(В) Это означает, что

^(Р) = М+Г )-РД-ГГ (2.72)

Дифференцируя предыдущее распределение по р, получим плот-

ность вероятности для преобразования у=х2

ЛДР) =

рДР2//2р2 +рД-У)12У р:

0 в остальных случаях.

Если функция плотностей вероятности рх(а) симметрична отно-

сительно а=0, то из ф-лы (2 73) следует

(2.73)

Л/(Р) =

(2.74)

0 в остальных случаях.

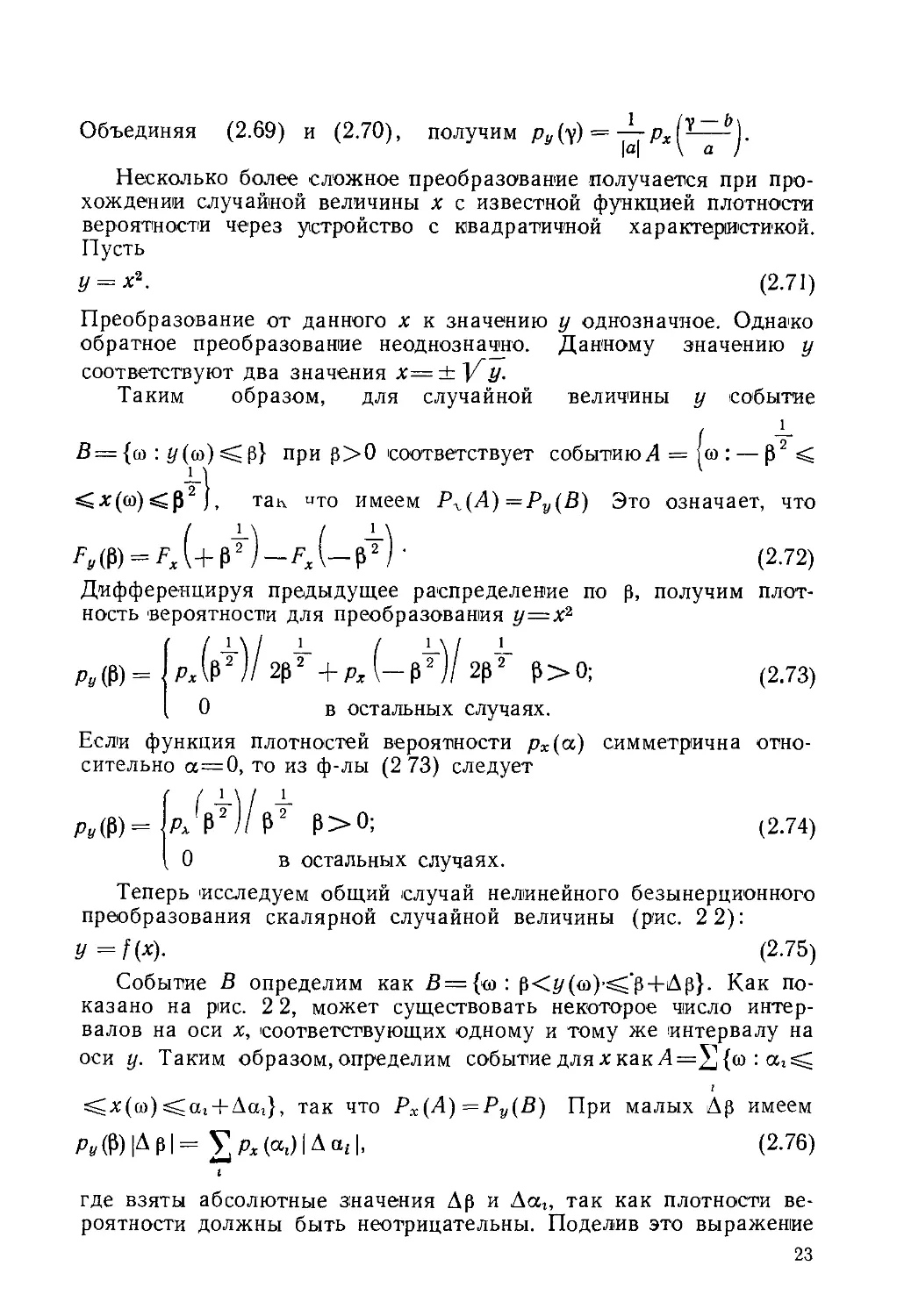

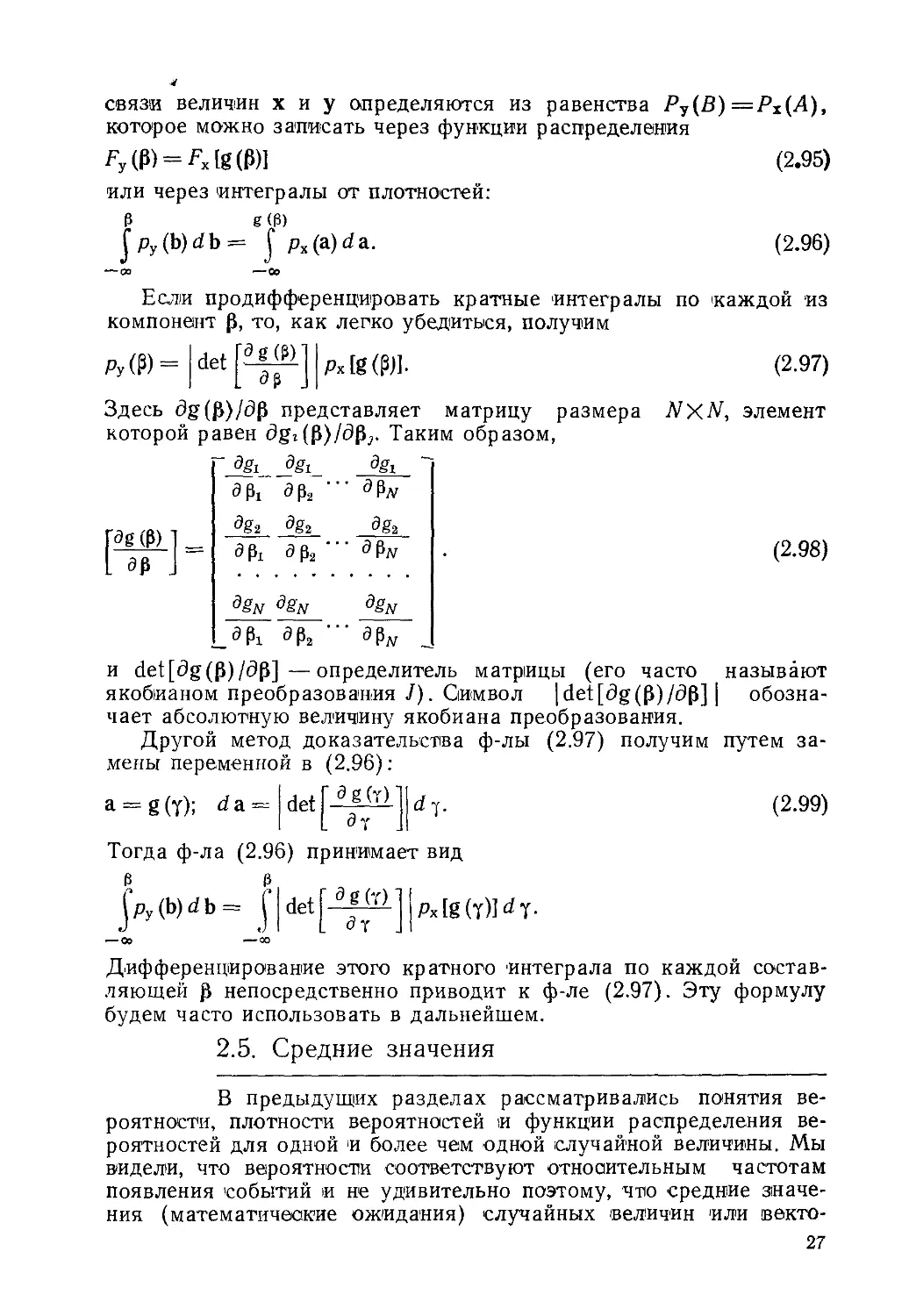

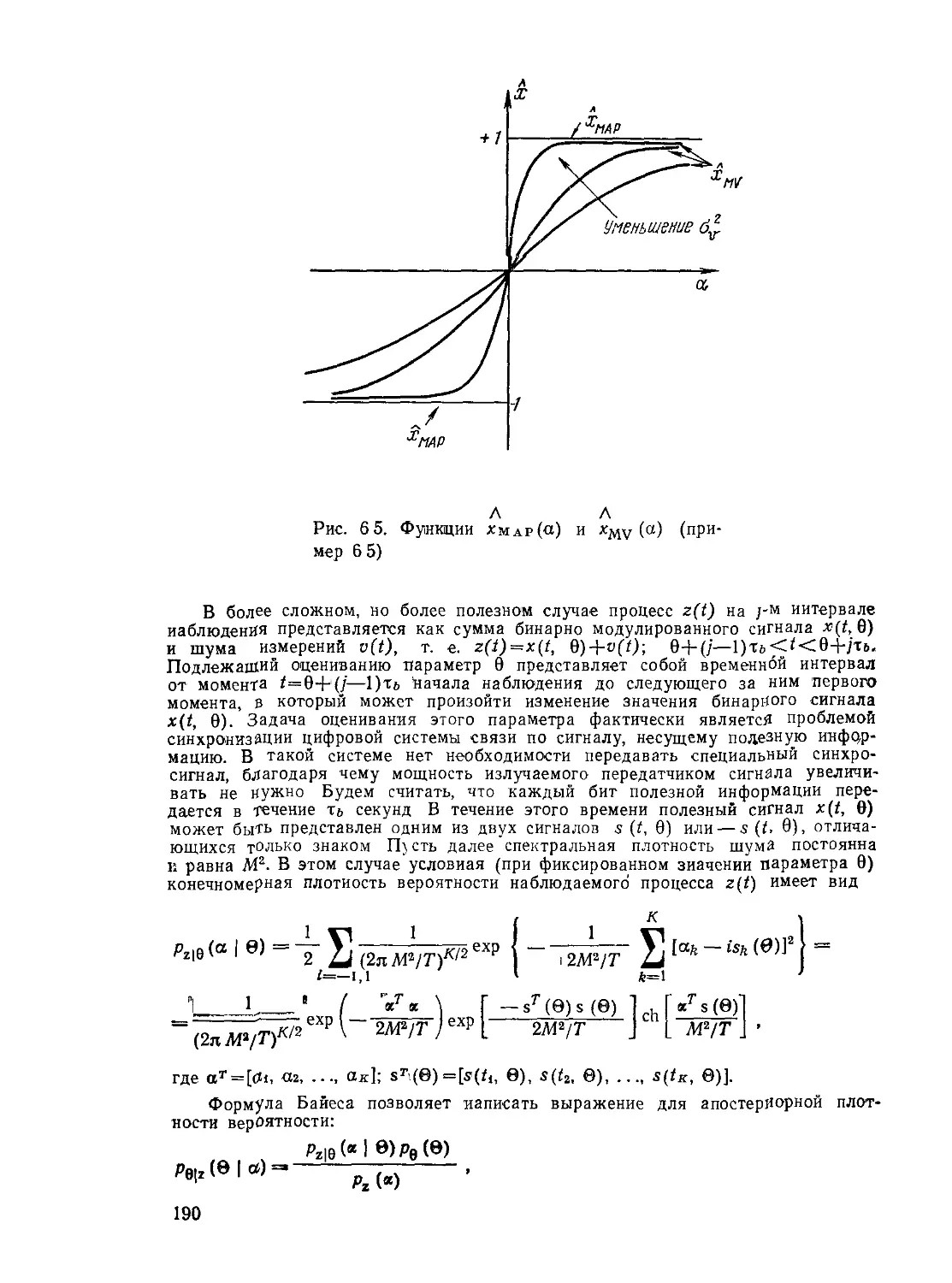

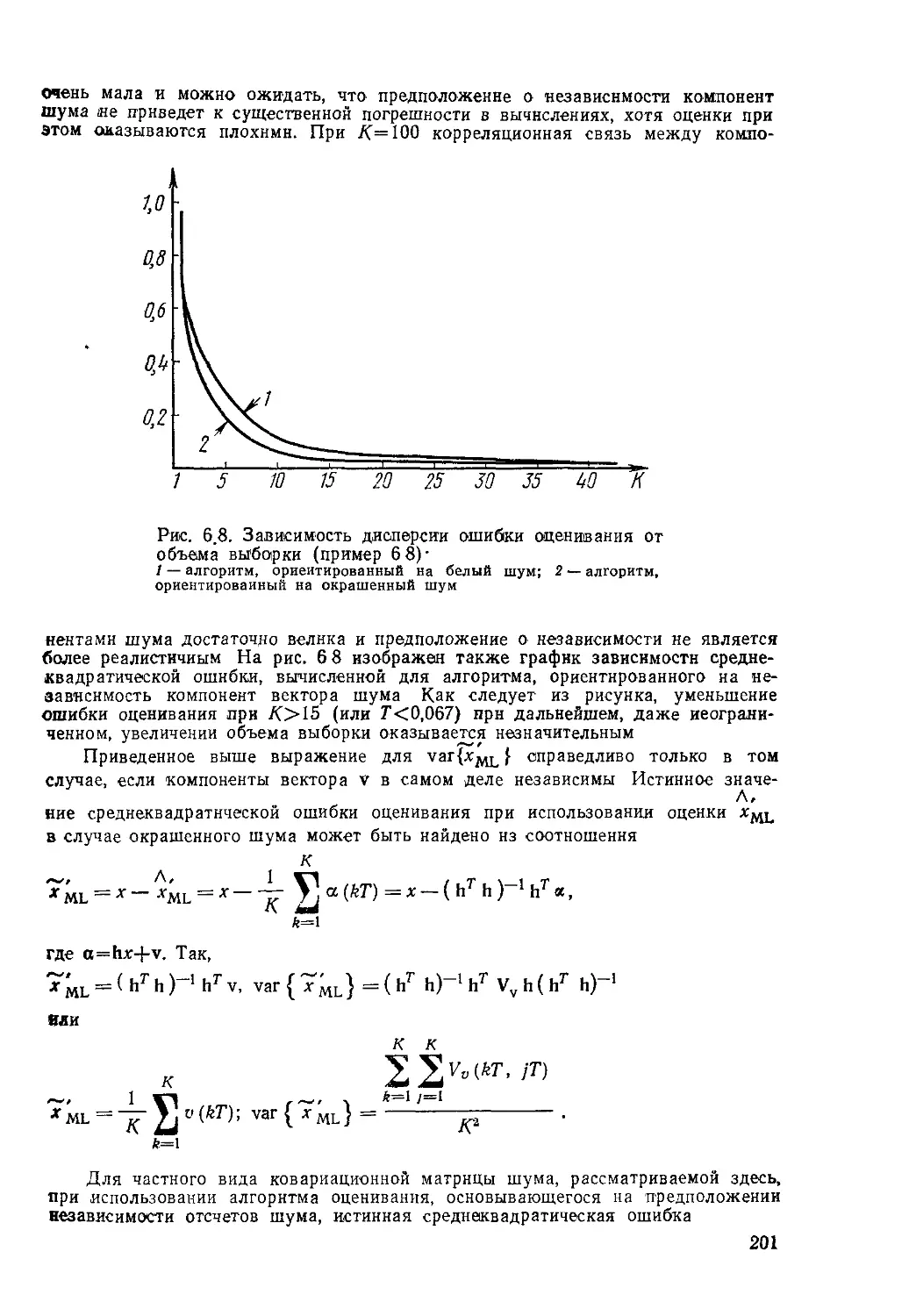

Теперь исследуем общий случай нелинейного безынерционного

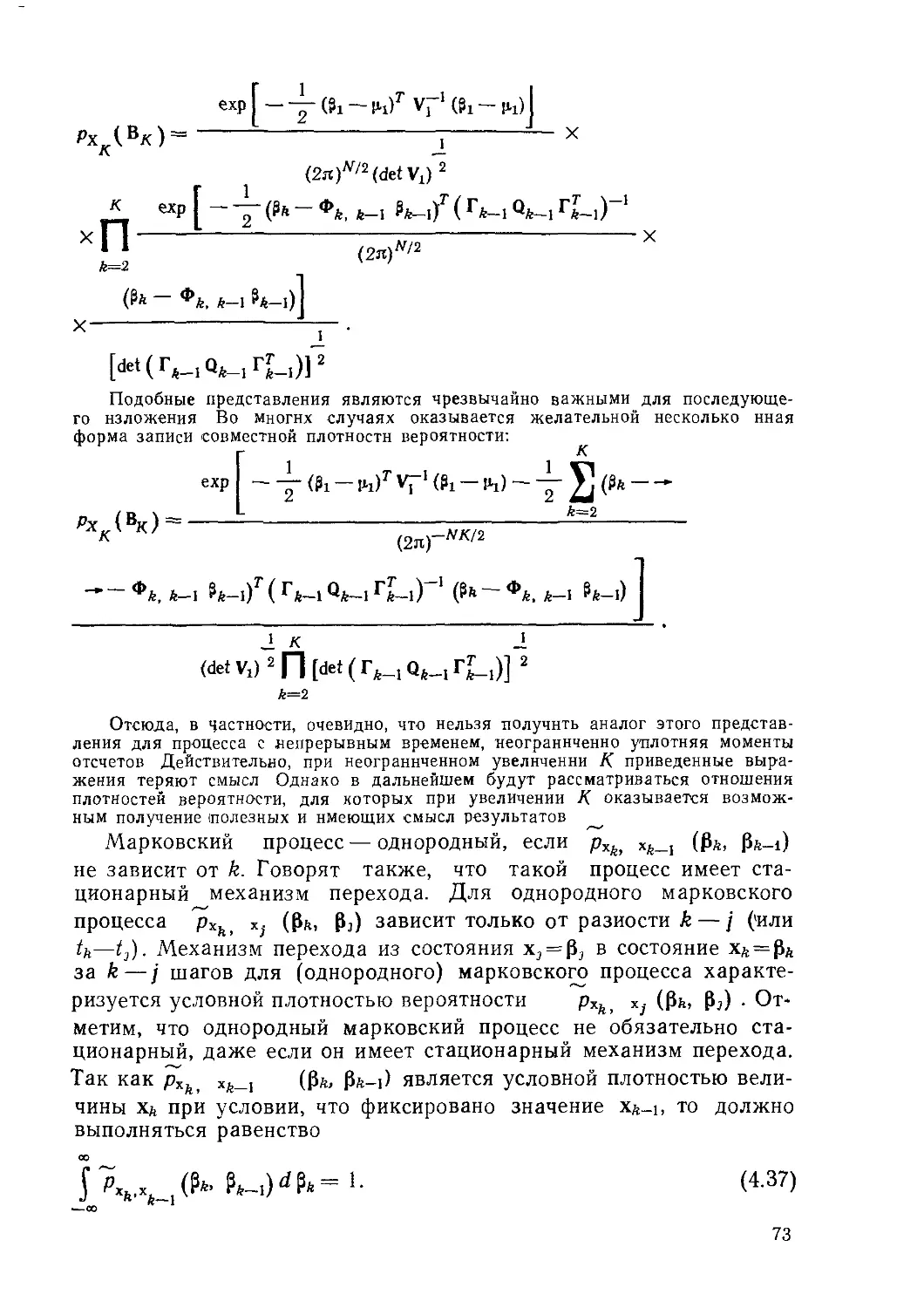

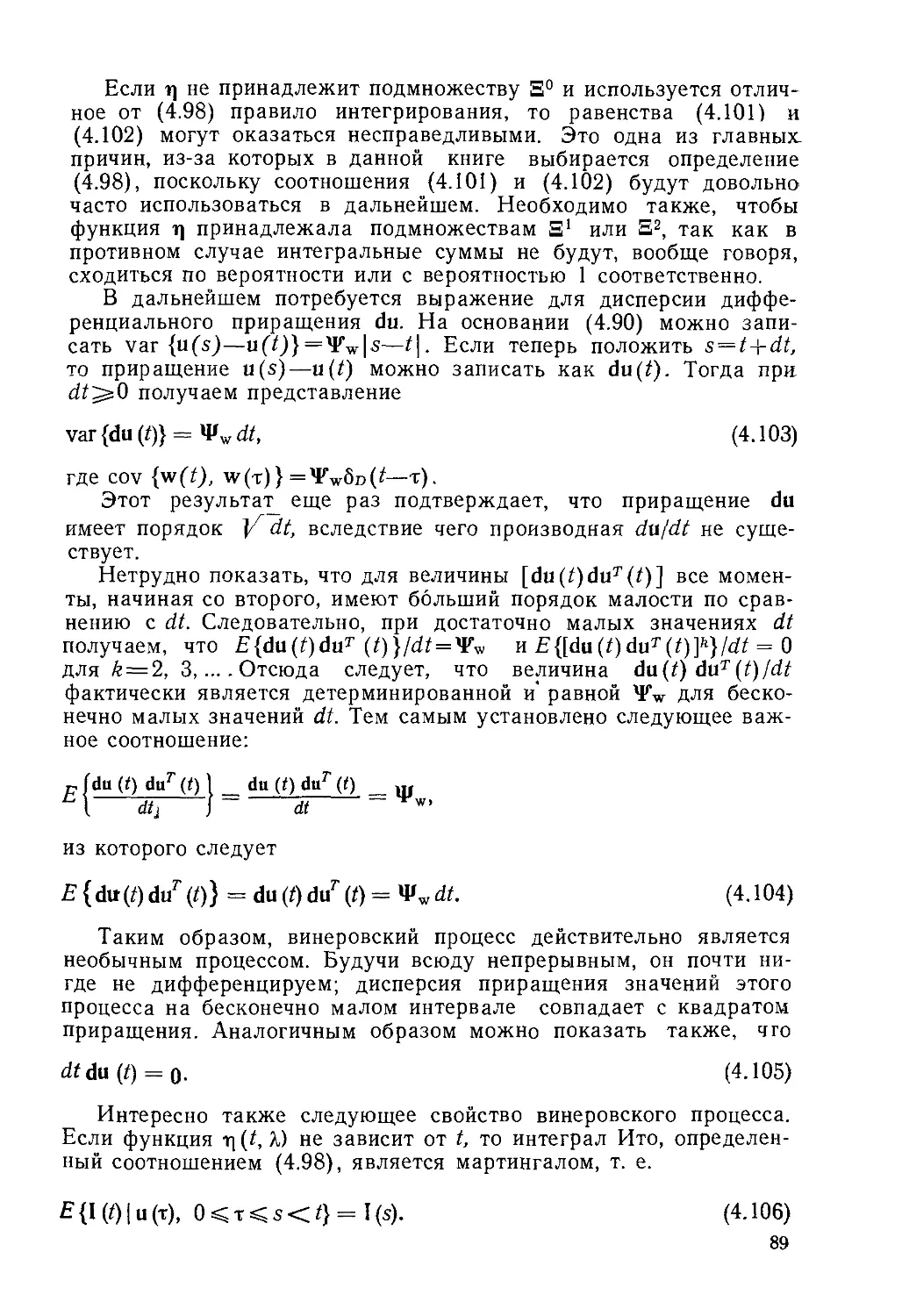

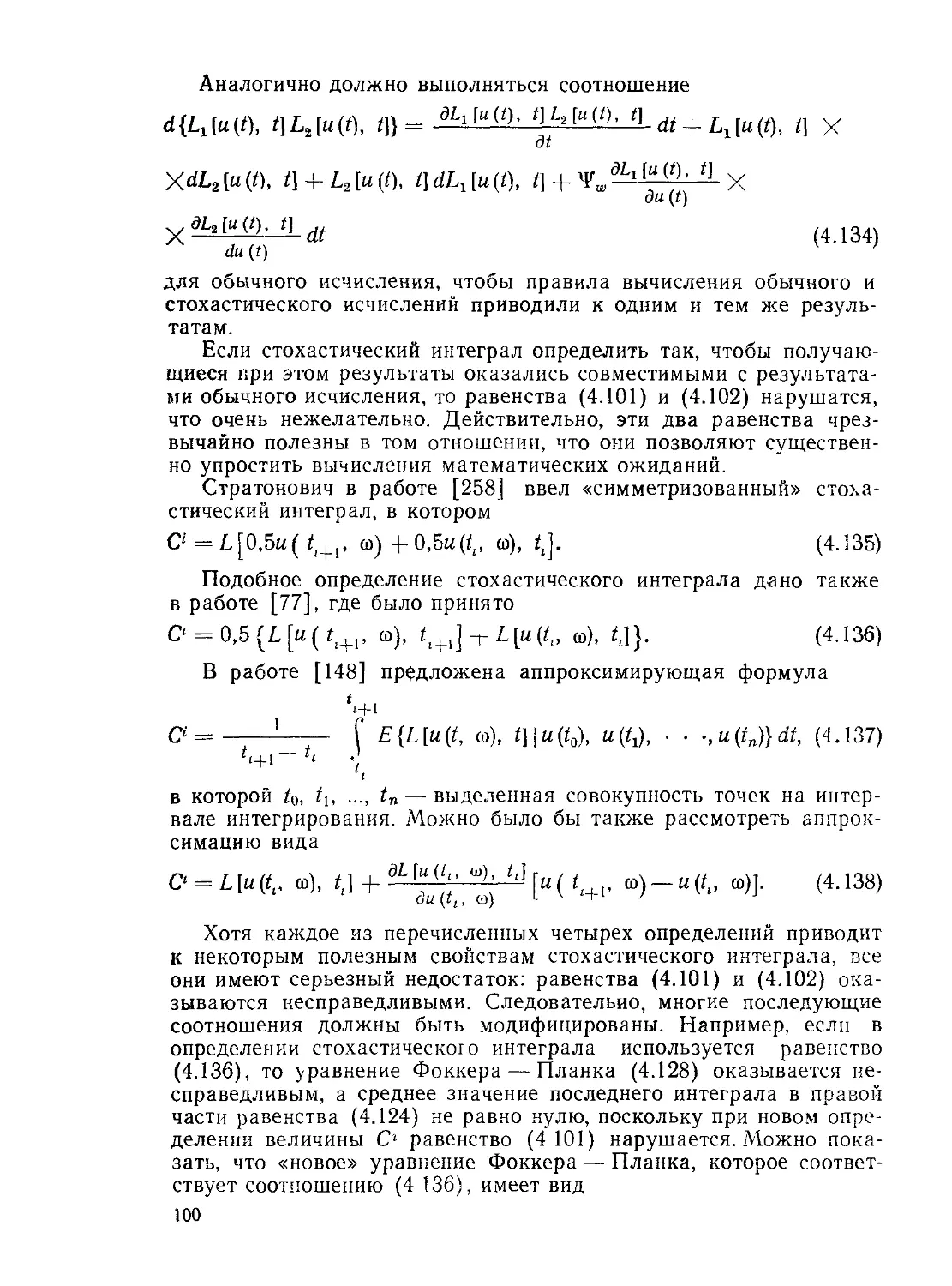

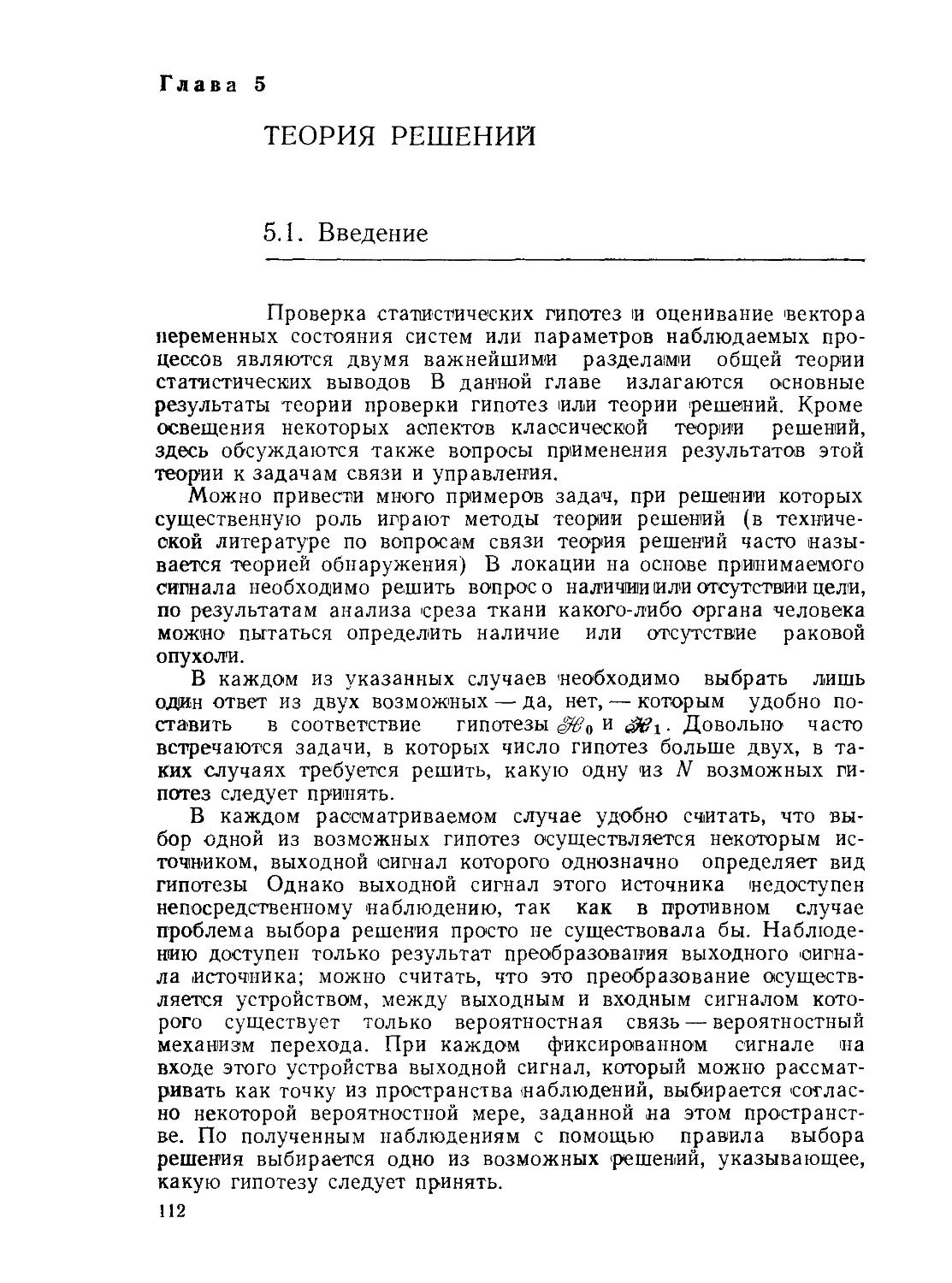

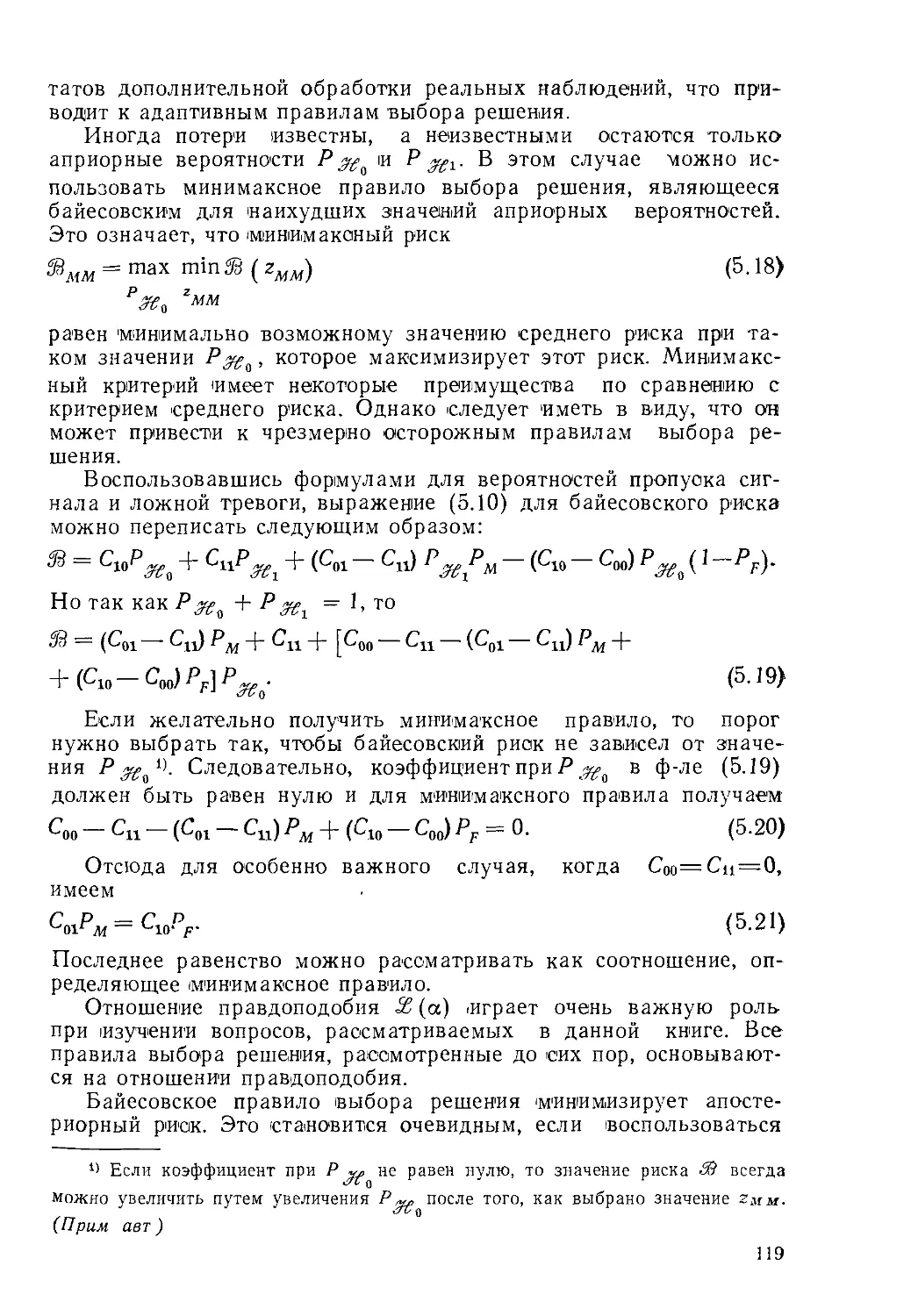

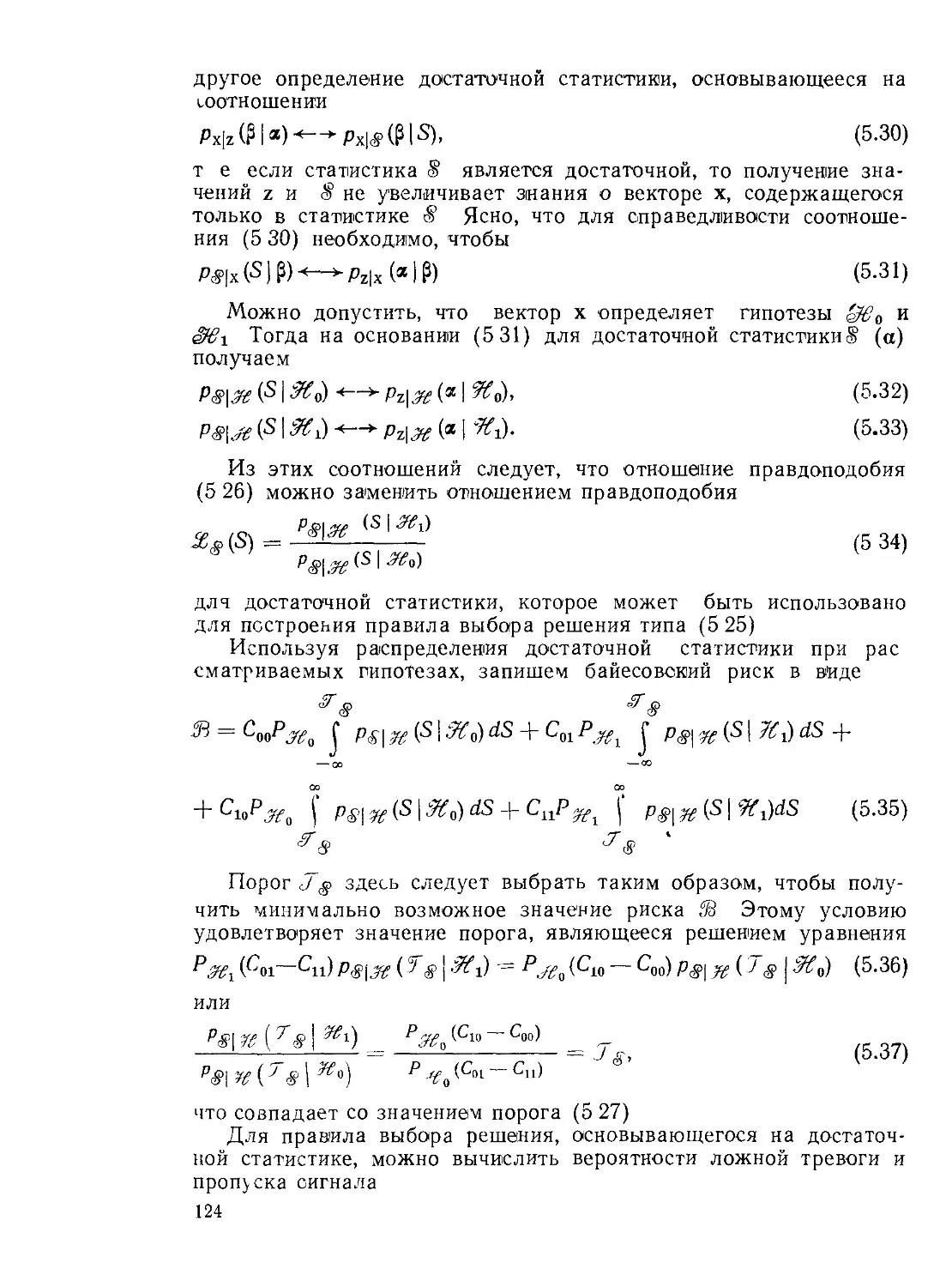

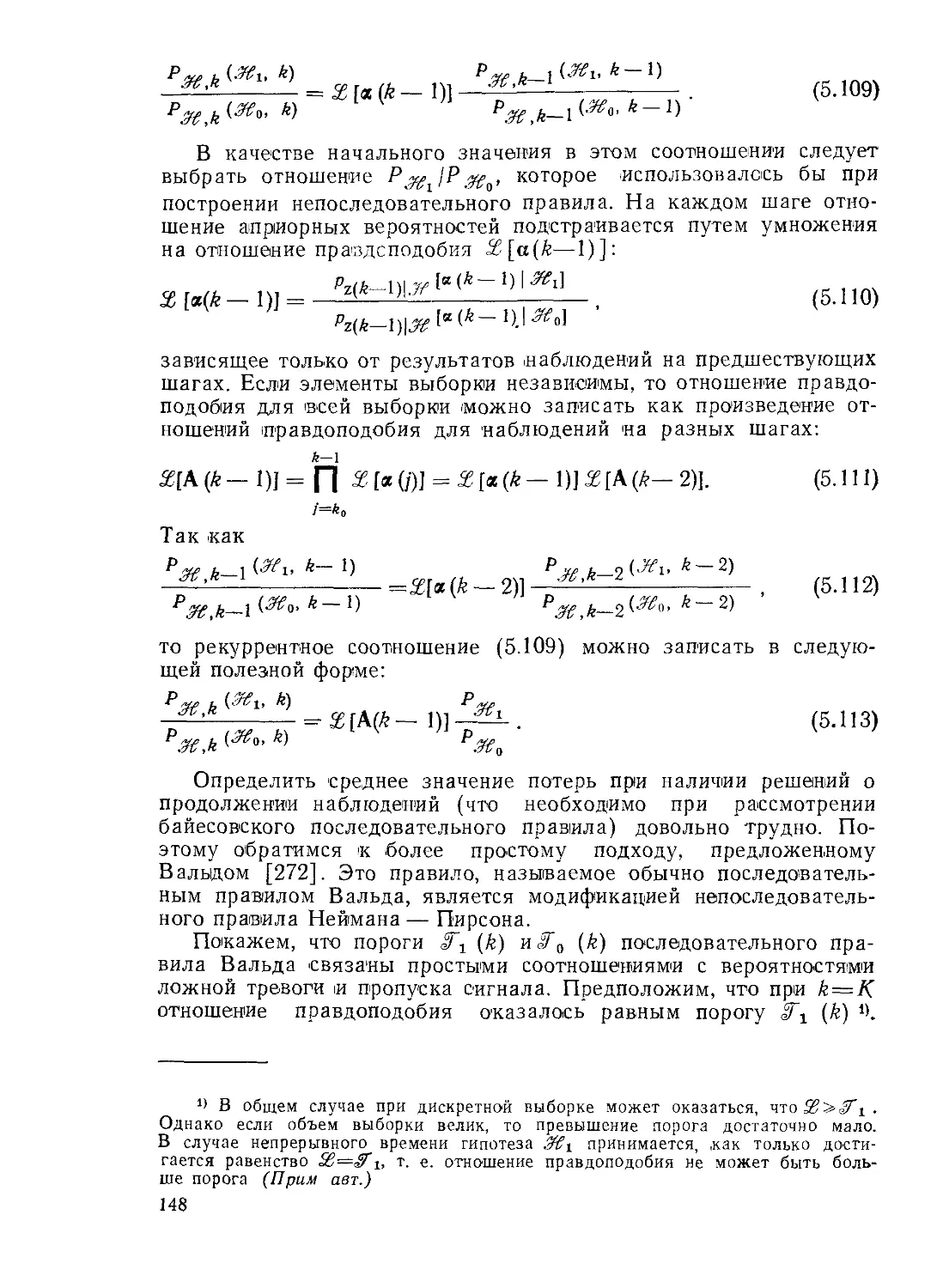

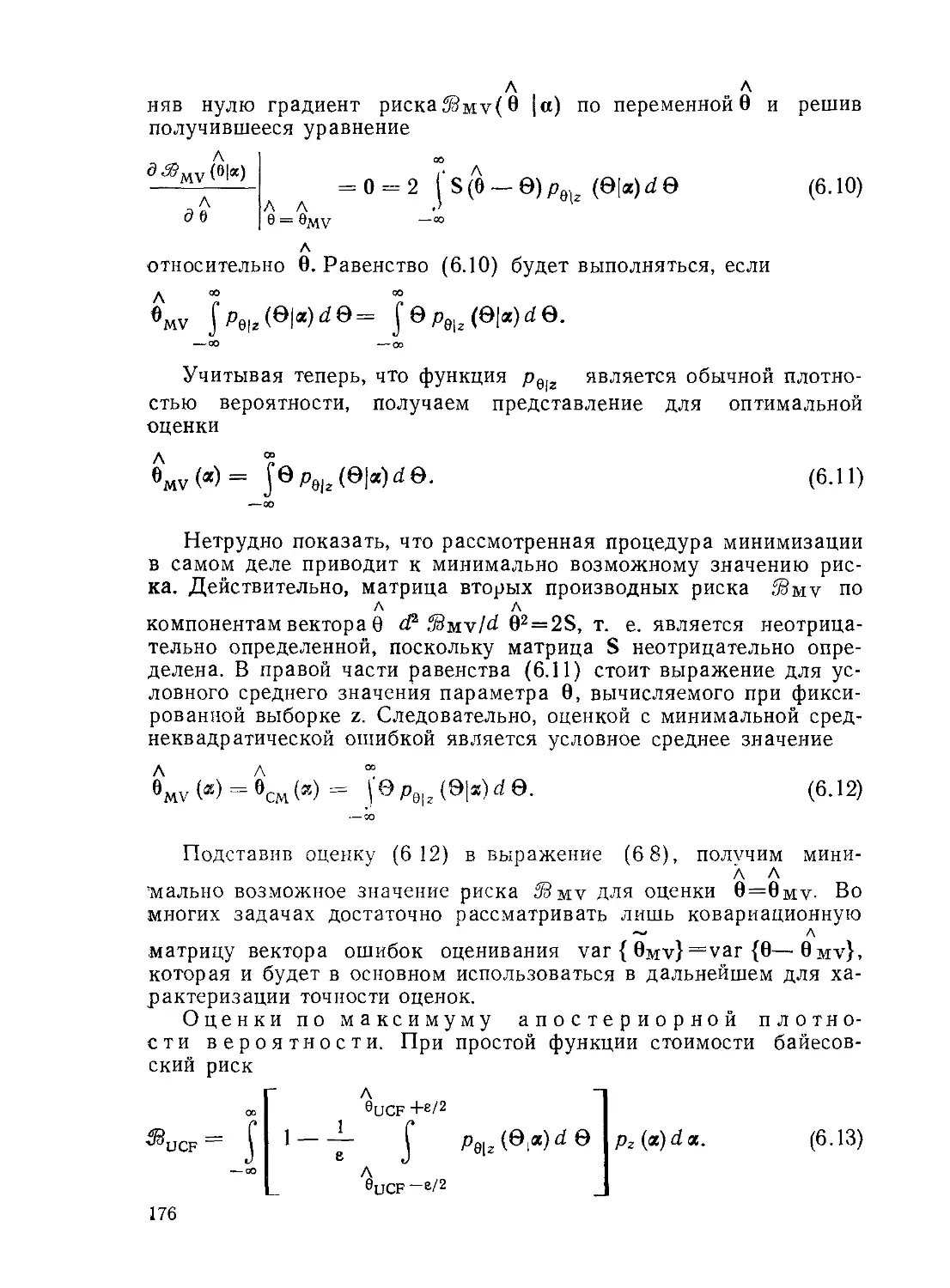

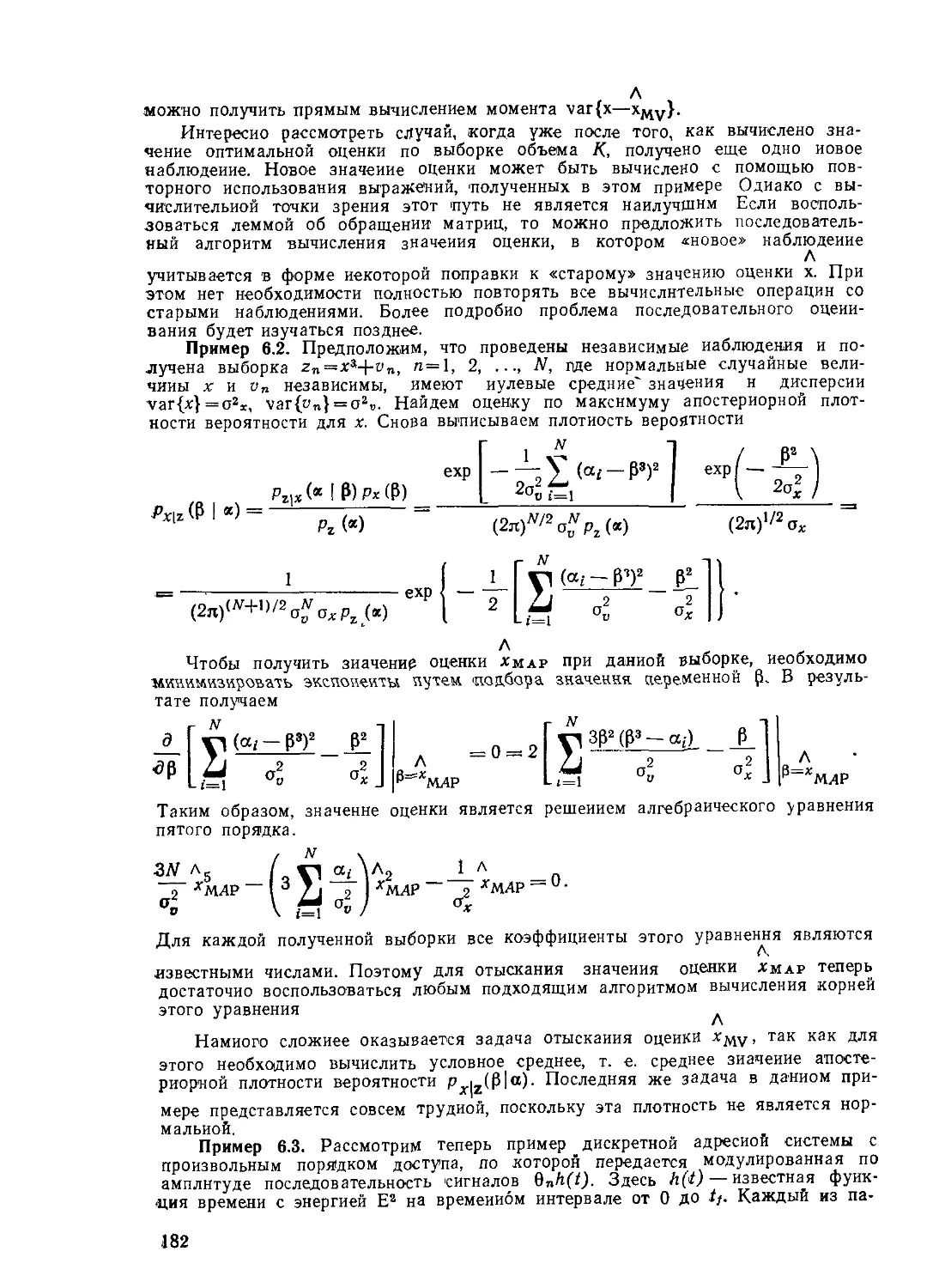

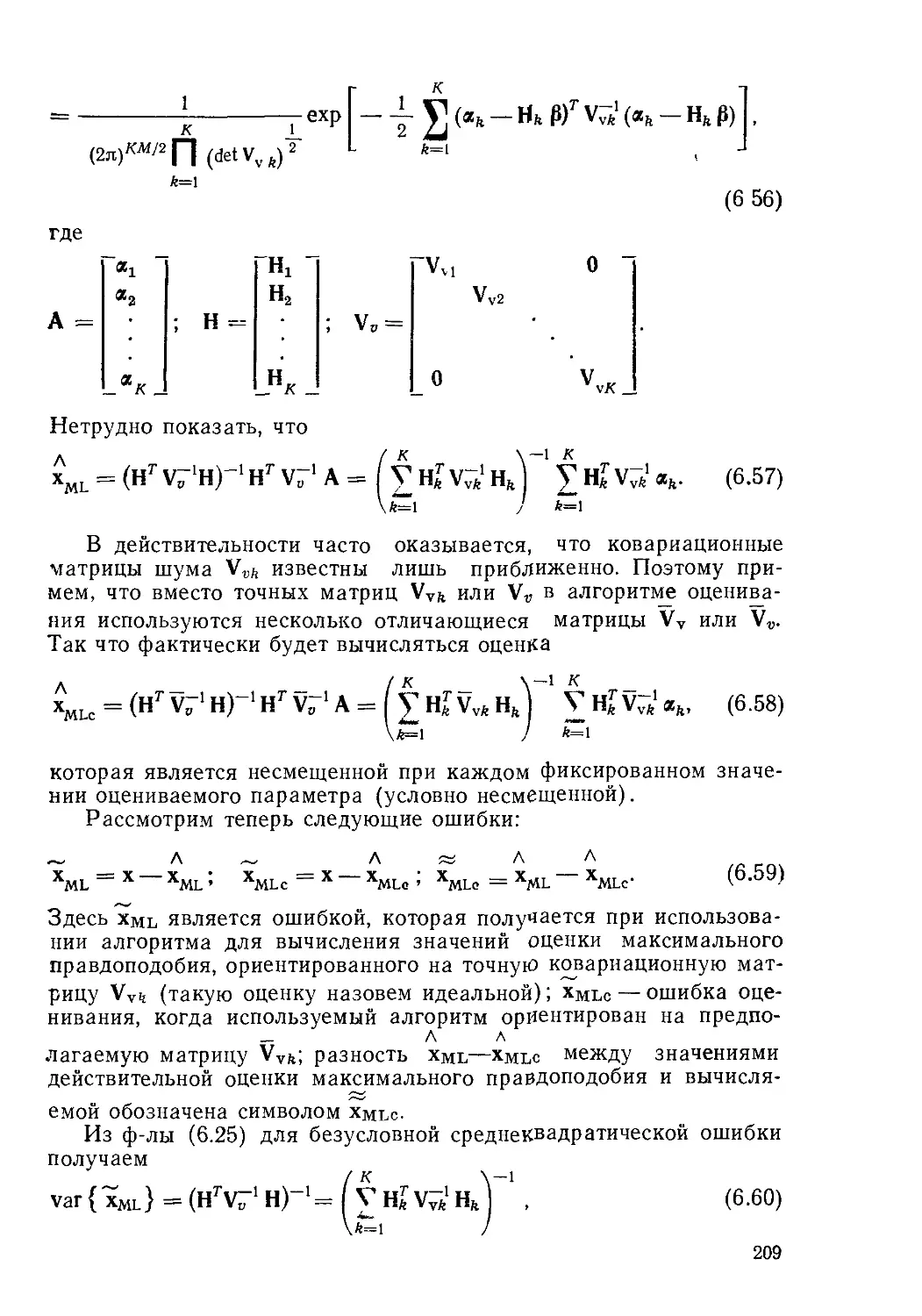

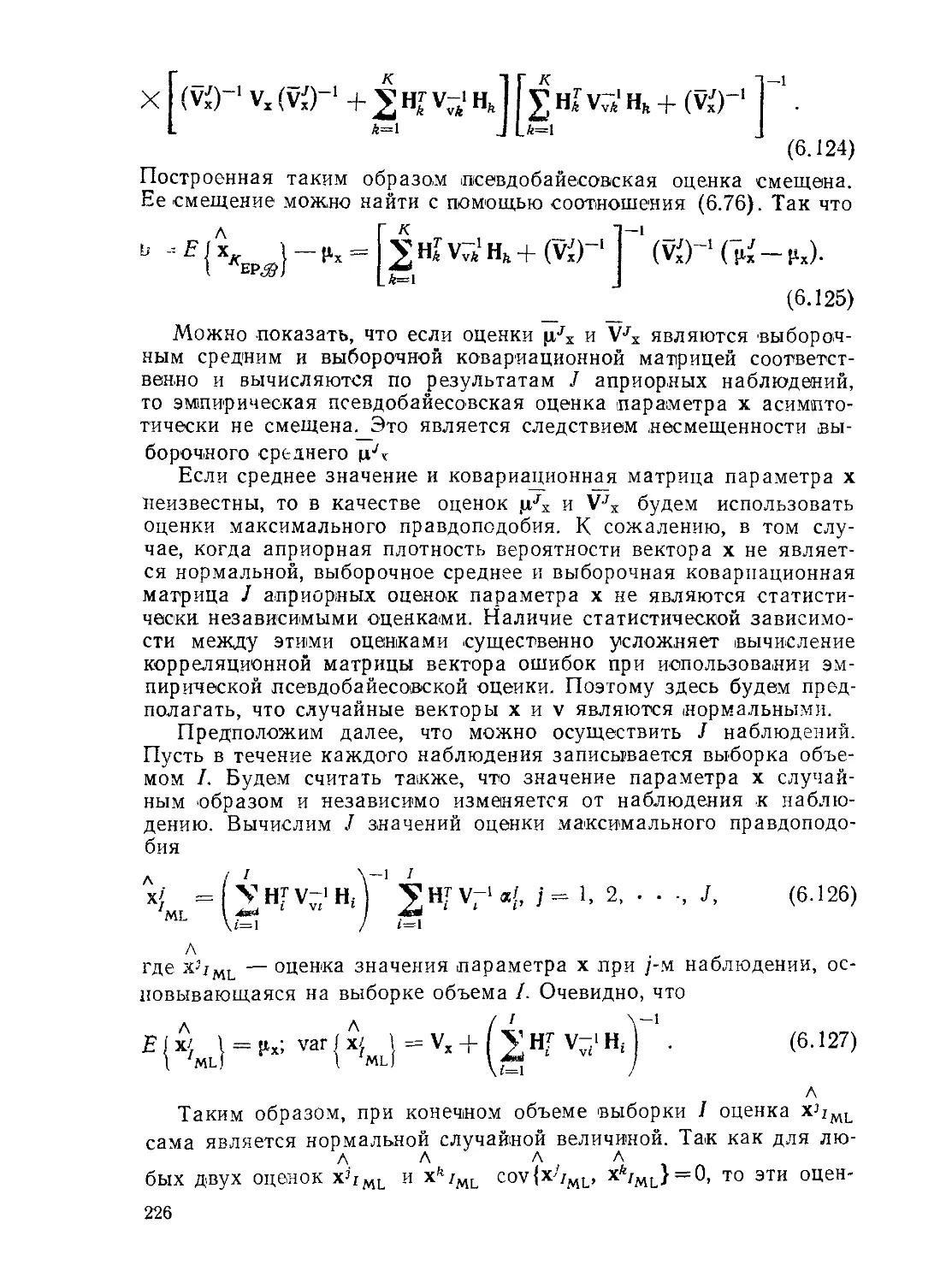

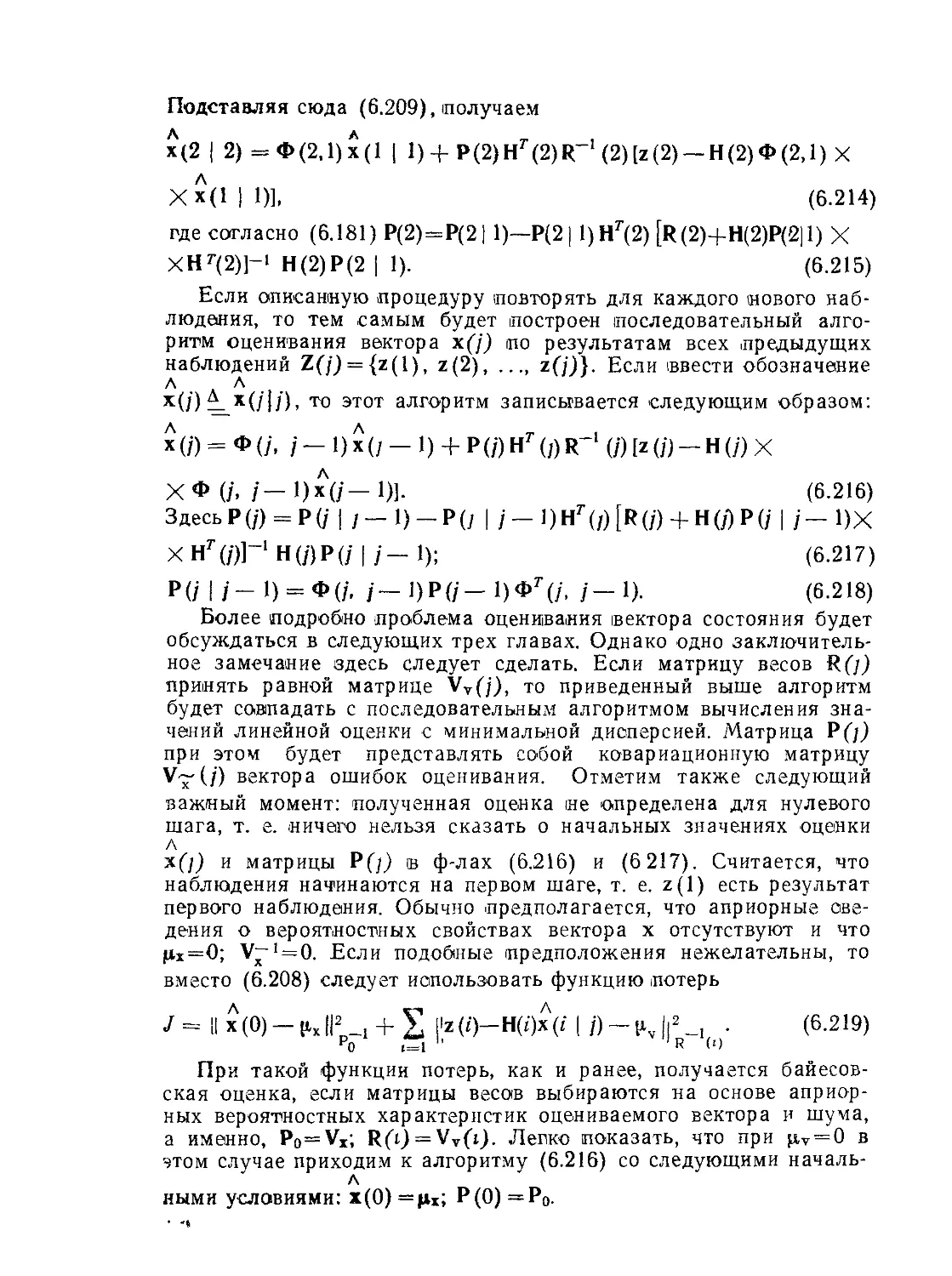

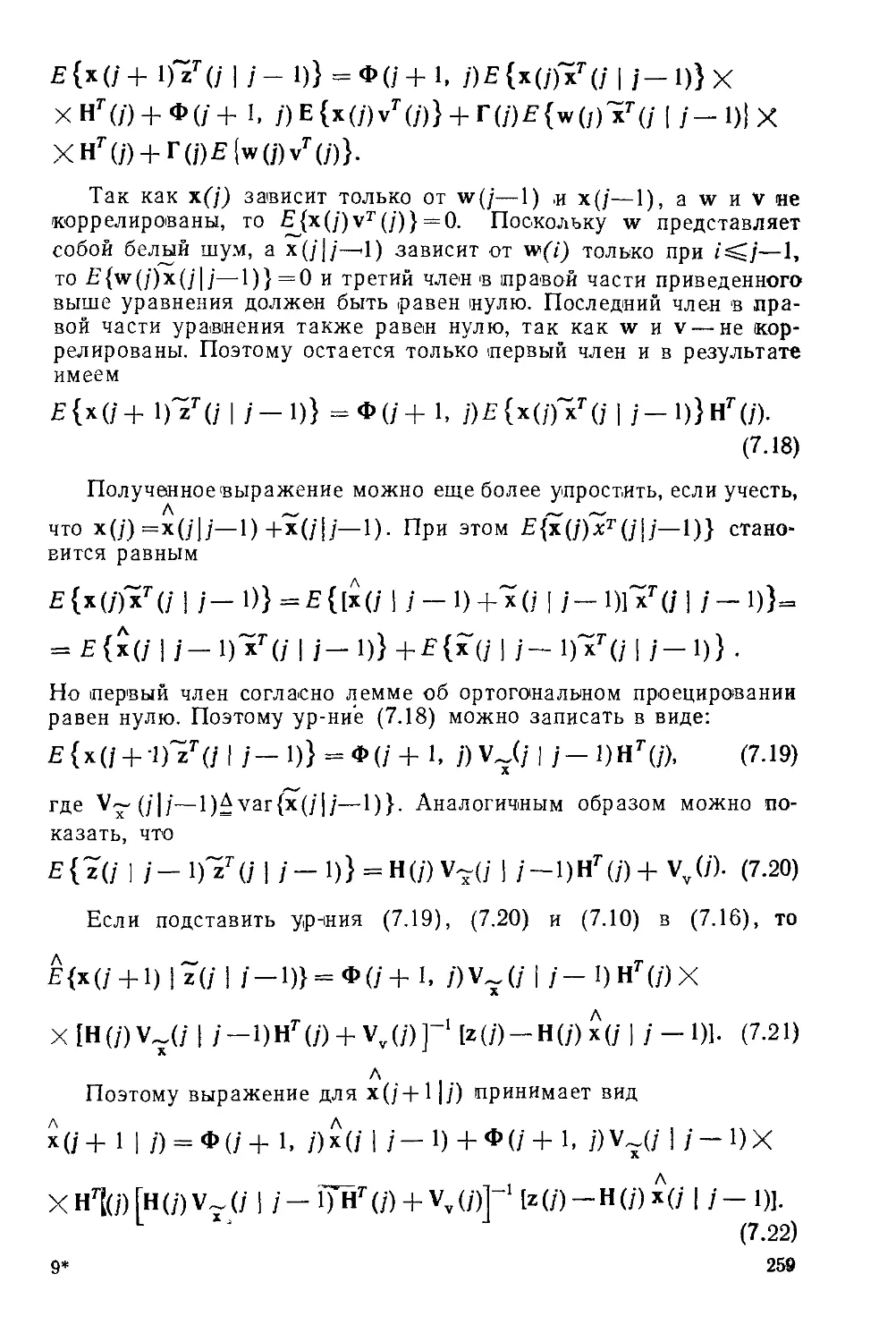

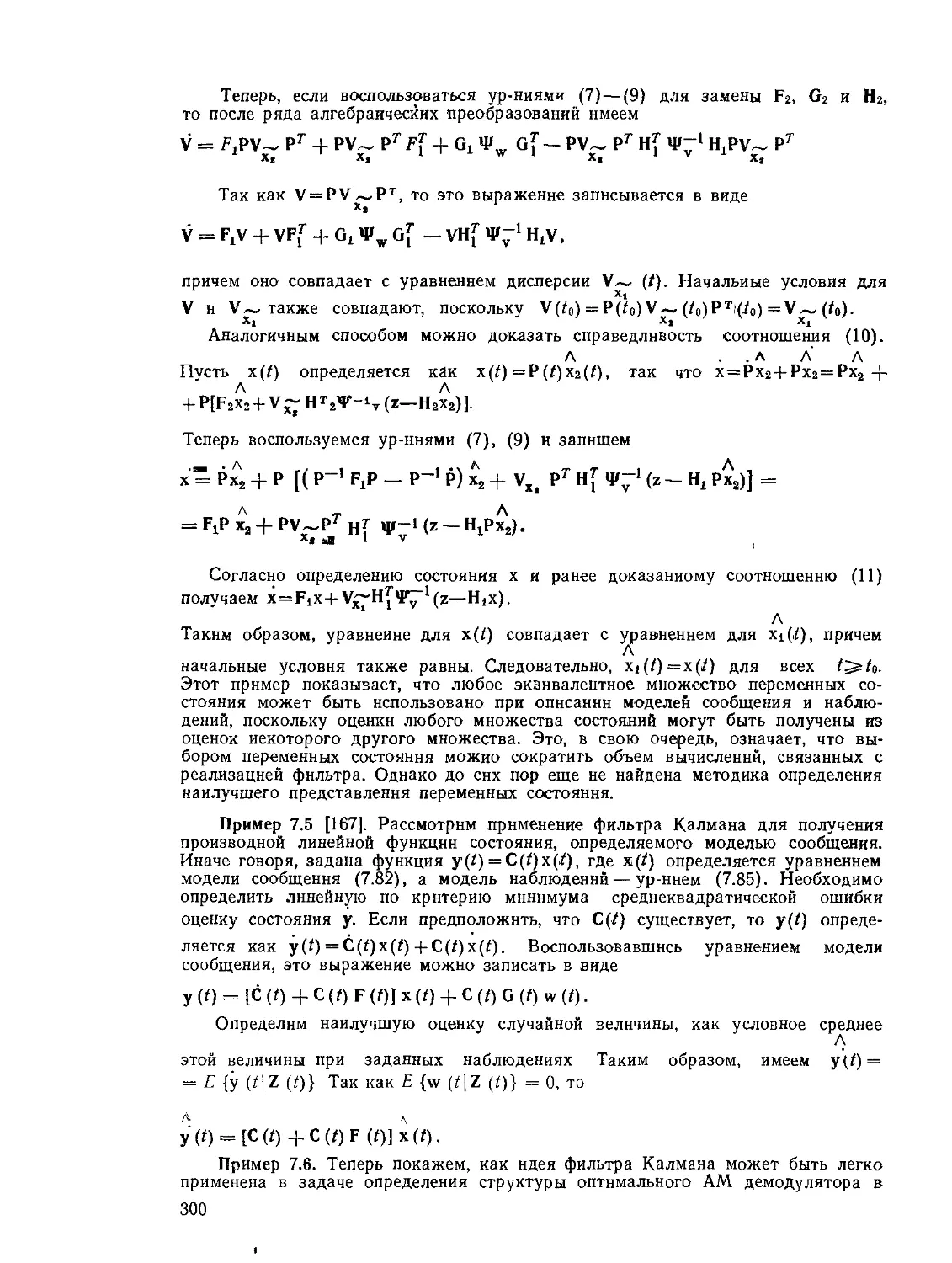

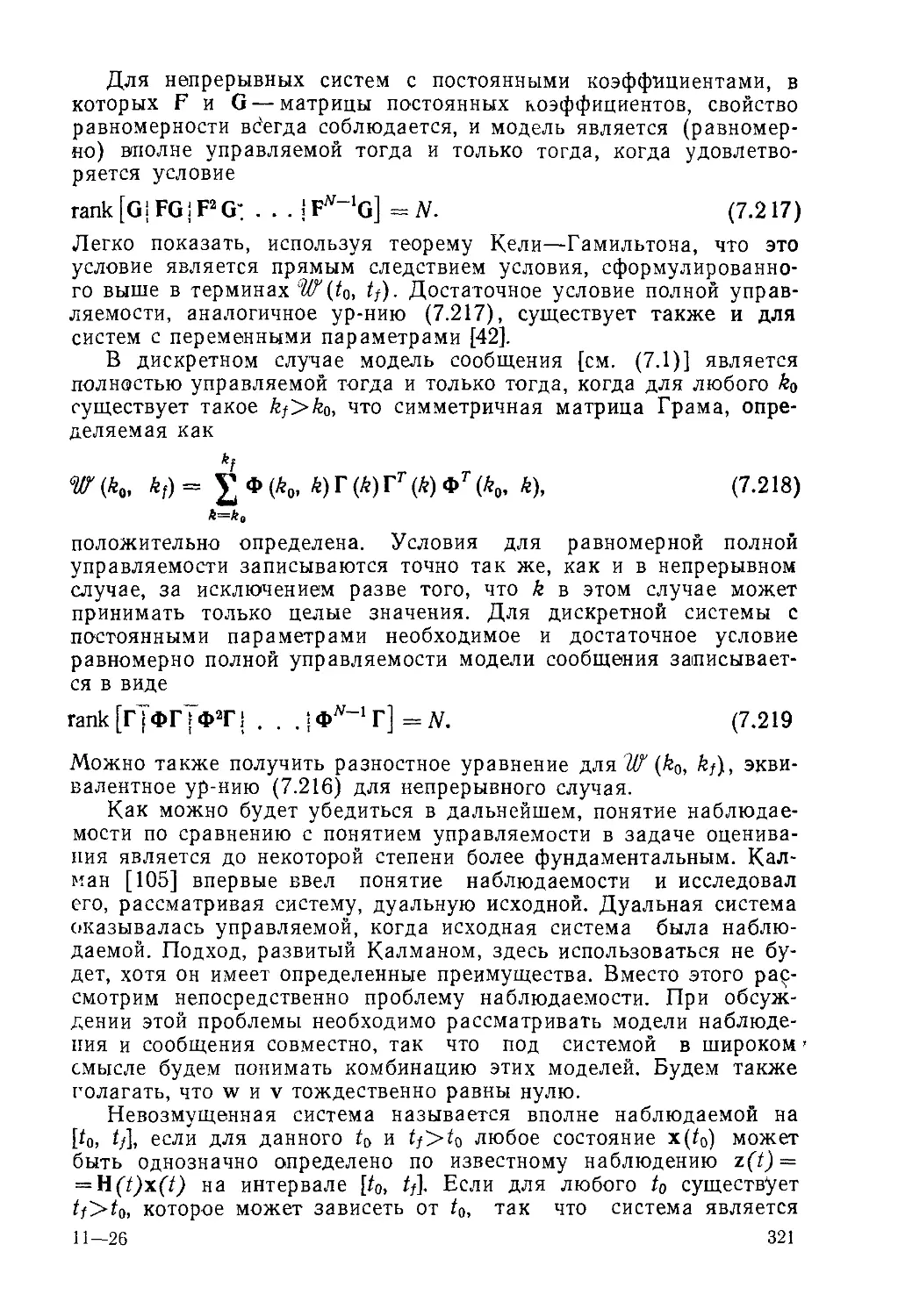

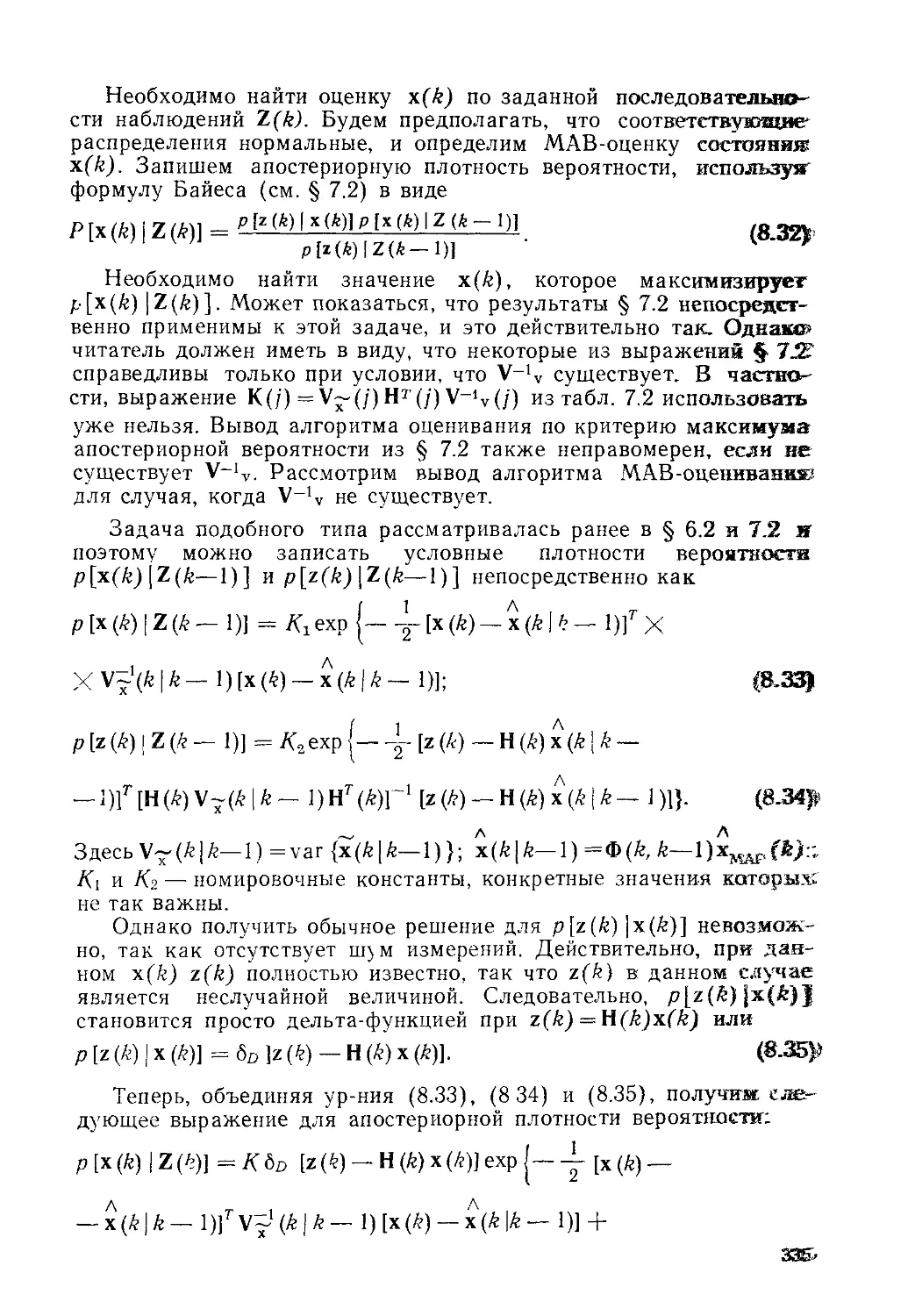

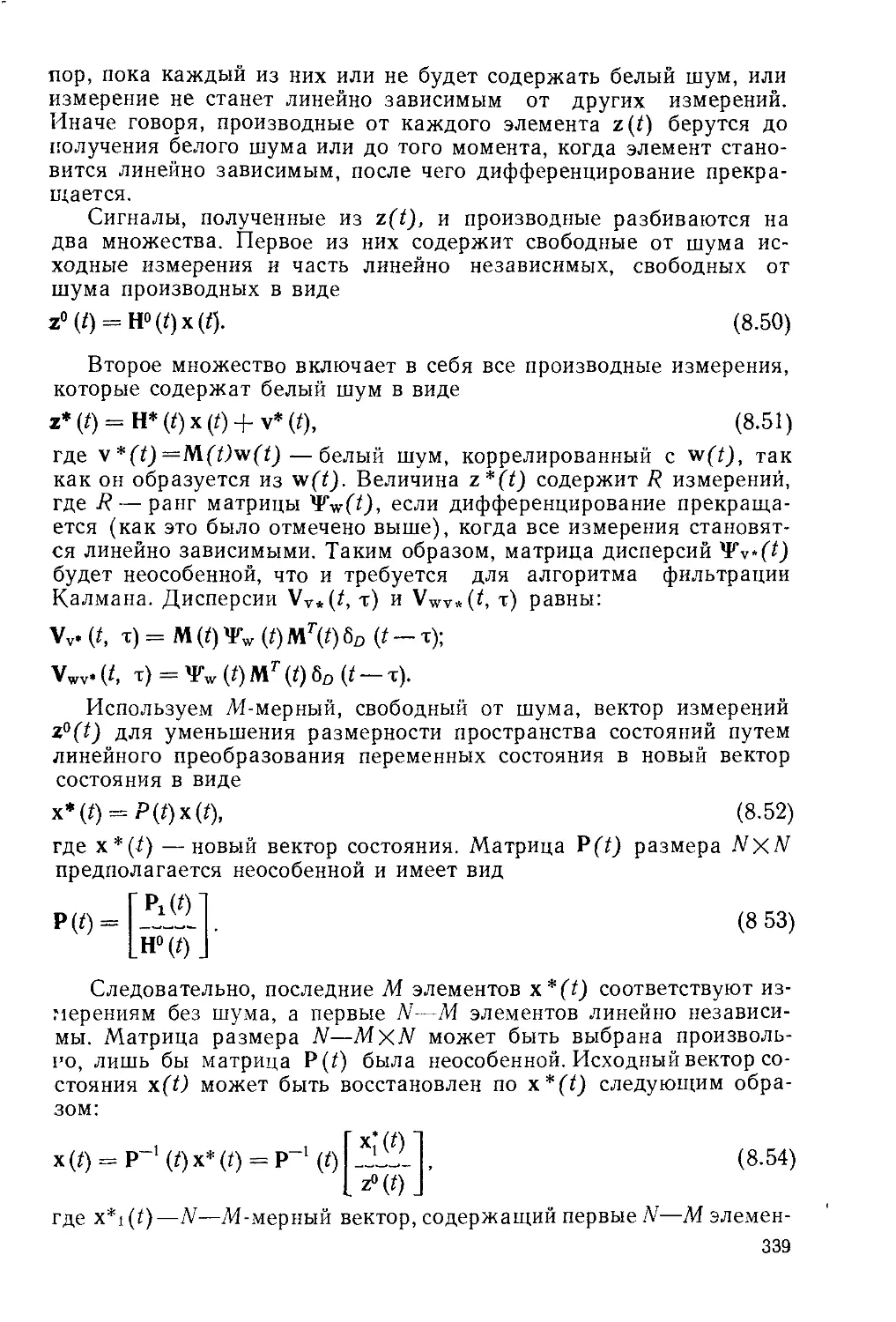

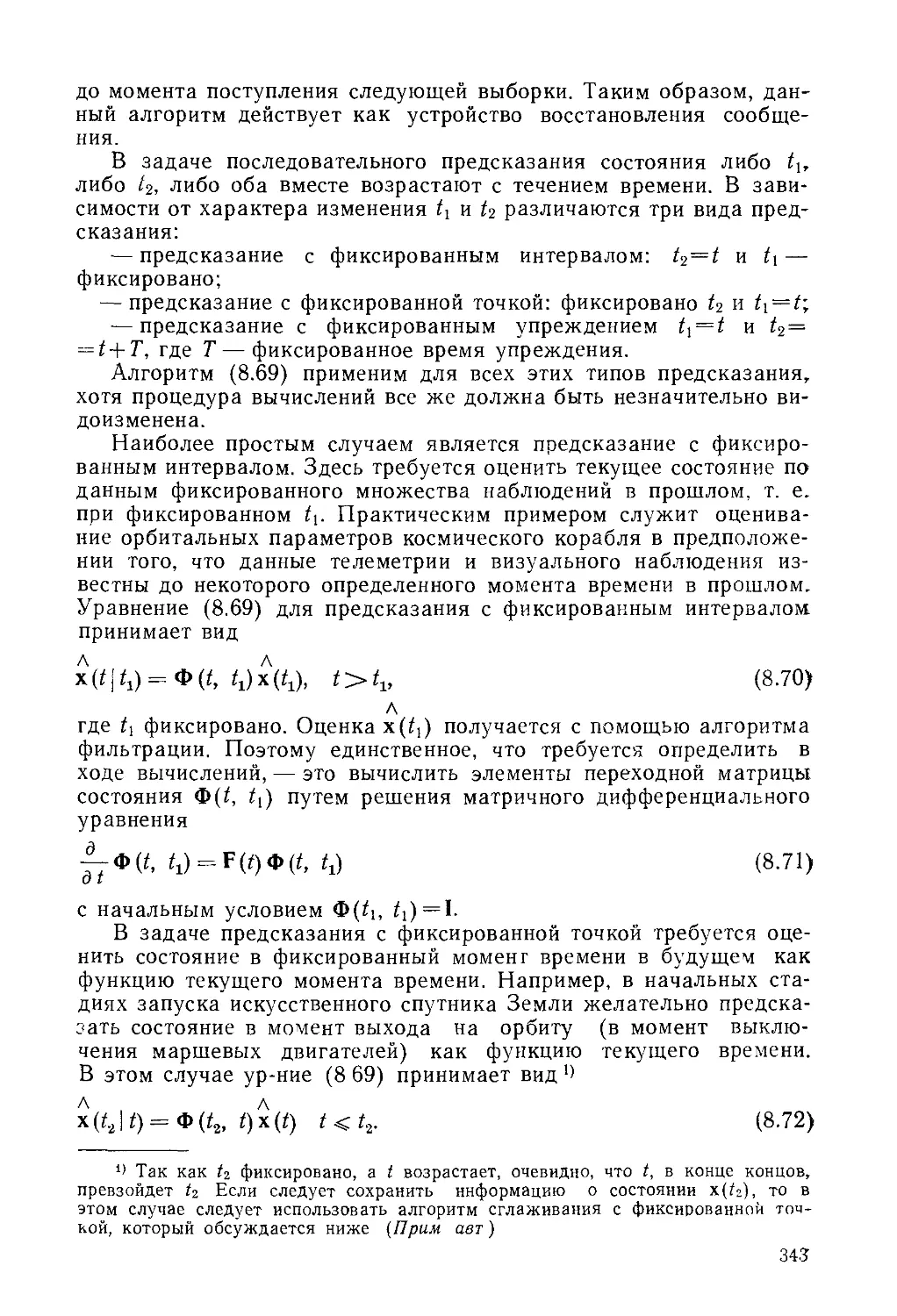

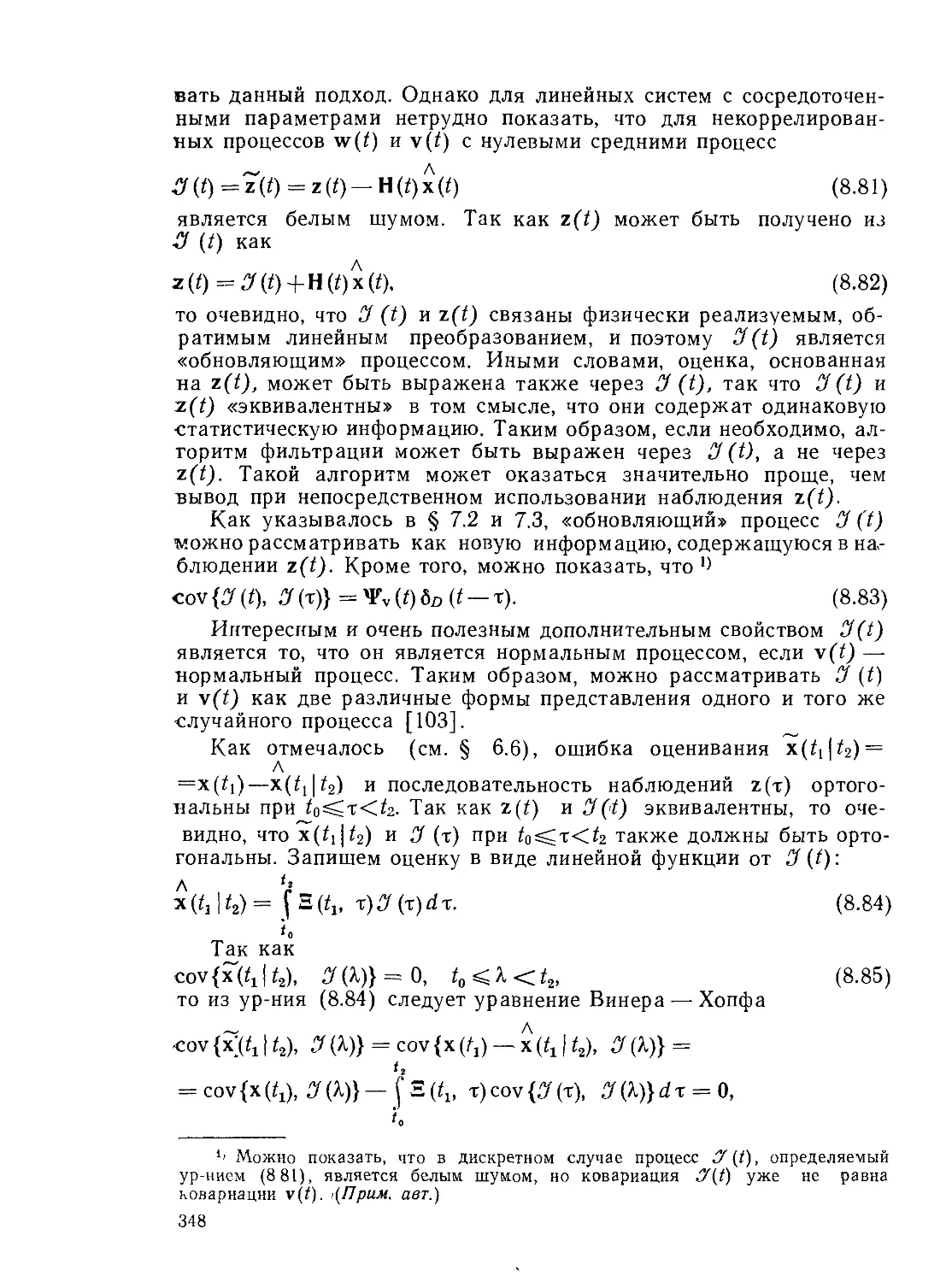

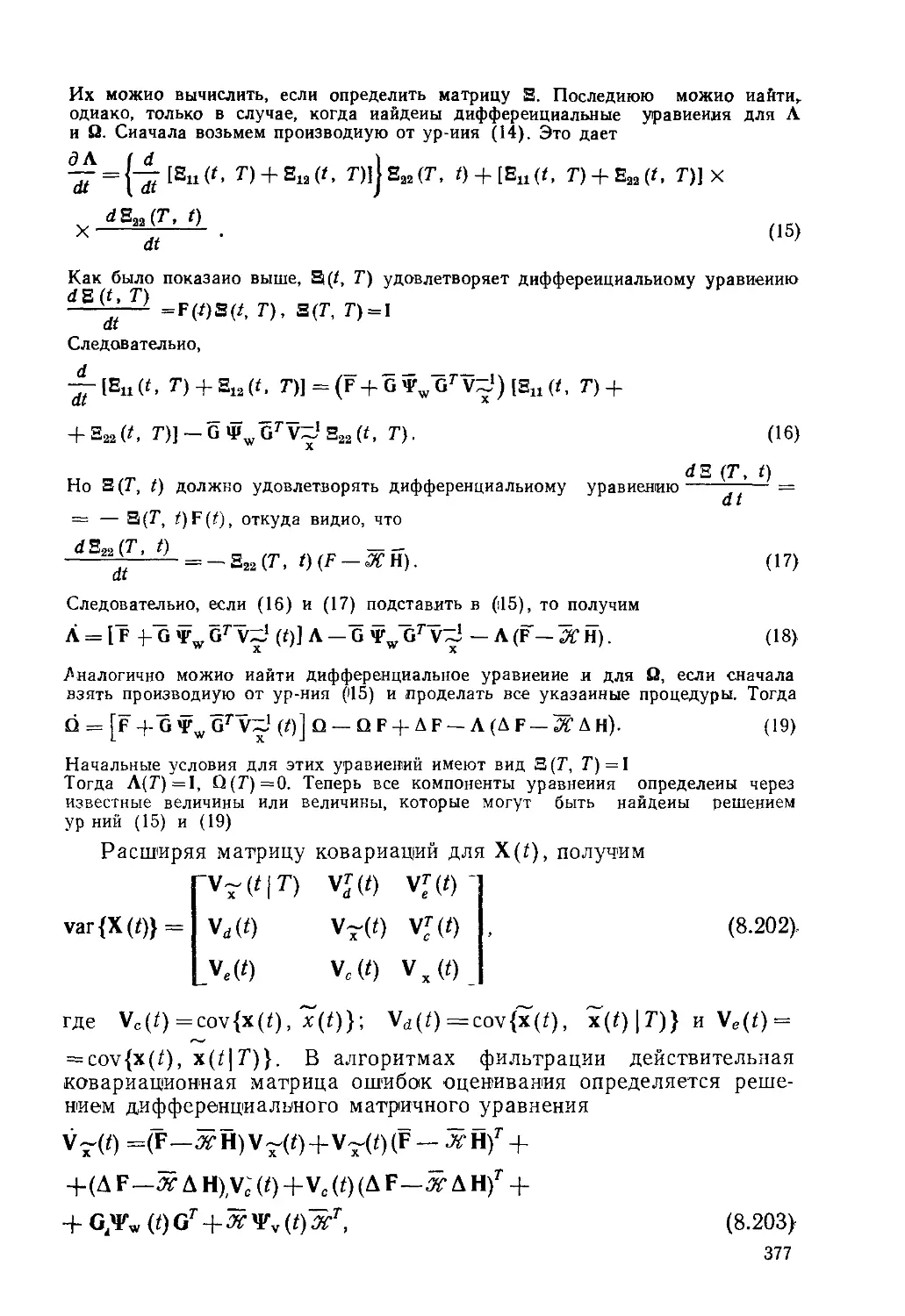

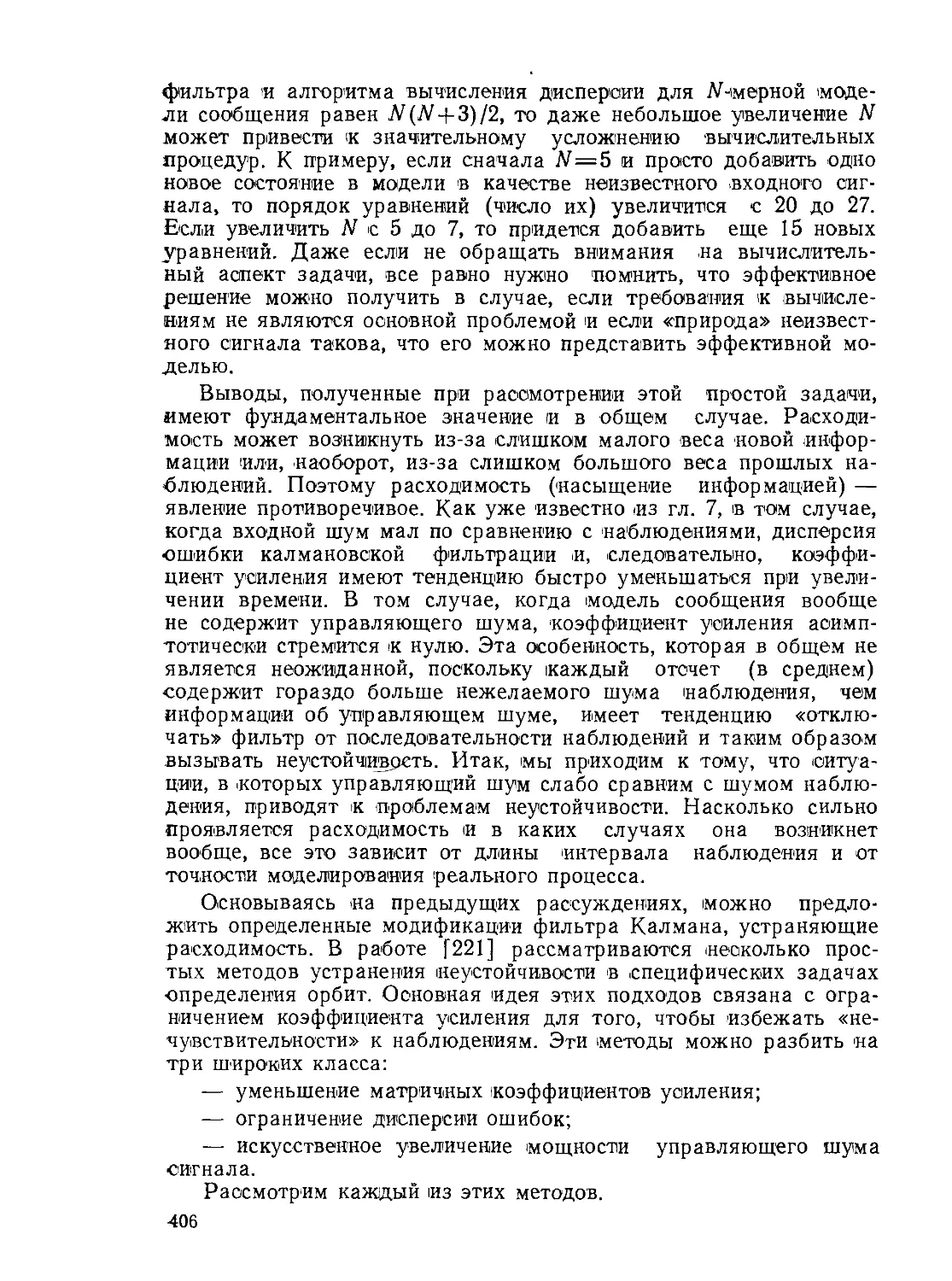

преобразования скалярной случайной величины (рис. 2 2):

У=Цх). (2.75)

Событие В определим как В = {<о : р<г/(<о)’^’р+Др}. Как по-

казано на рис. 2 2, может существовать некоторое число интер-

валов на оси х, соответствующих одному и тому же интервалу на

оси у. Таким образом, определим событие для х как A =JJ{<o : a,sC

^х(со) ^щ + Да,}, так что РХ(А) = РУ(В) При малых Др имеем

Р«Ф) |д РI = £ Рх (аг) IД «г 1> (2.76)

где взяты абсолютные значения Др и Даг, так как плотности ве-

роятности должны быть неотрицательны. Поделив это выражение

23

на |Др | и перейдя к пределу при Др и Даг, стремящихся к нулю,

получим плотность вероятности для случайной величины у

Ру($>} = У.РЛЪ) тН(2.77)

dpi

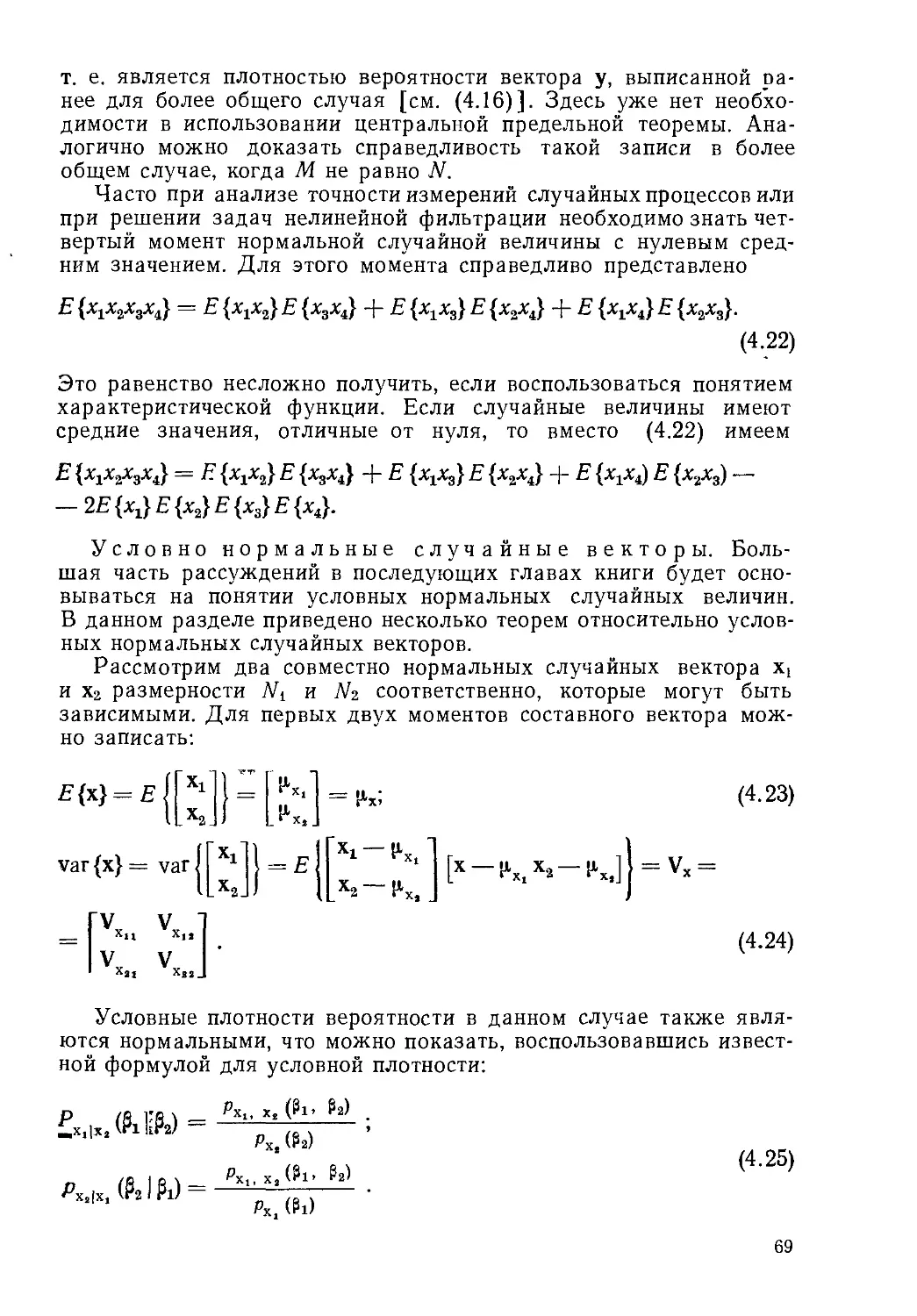

Рис 2 2 Общий вид не-

линейного безынерцион-

ного преобразования

где i распространяется на все значения х=аг, которые соответ-

ствуют у=$ Значения аир связаны между собой ур-нием

(2 75). Если множество решений ур-ния (2.75) имеет вид

₽ = f(a,)> «Ч = &(₽), (2-7 8)

то окончательно имеем

(2.79)

Этот результат является наиболее общим выражением для

плотности вероятности скалярной случайной величины у, полу-

ченной с помощью алгебраического преобразования скалярной

случайной величины х

Во многих задачах теории оценивания две или более случай-

ные величины комбинируются для формирования скалярной или

векторной случайной величины. Например, одной из важных за-

дач, которая будет изложена ниже, является оценка сигнального

вектора х по наблюдаемому процессу z, который является адди-

тивной смесью шума v и нелинейного преобразования сигнала

z = h [х] + у. (2.80)

Вначале рассмотрим несколько простых вариантов комбина-

ций случайных величин, а затем перейдем к более сложным. Од-

ной из самых простых комбинаций является сумма двух скаляр-

ных случайных входных сигналов

г = х-{-у. (2.81)

Предположим, что известна совместная плотность вероятнос-

ти х и у и необходимо определить плотность z. Если обозначить

события В = {и : г(и) Оу, х(<в) —а} иЛ = {<в : у(й)’О'у—<х,х(<в) =

= а}, то PZ(B) =РУ(А) и

Fz\x (у|а) = Fyix(y — а|а). (2.82)

24

Дифференцируя это выражение по у, получим

Рг\х (у|а) == Ру\х (у — а|а). (2.83)

Но согласно (2.51) совместные плотности вероятности являются

произведениями условных и индивидуальных плотностей, т. е.

Рг,х(у. а) = р2|х(у|а) рх(а); (2.84)

Рх.у (а. У — «) = Ру\х (у — а|а) рх (а).

Умножая обе части (2.83) на рж(а), получим

(2.85)

Рг,х (у, а) = рХ:у (а, у — а). (2.86)

Так как индивидуальные плотности можно получить интегриро-

ванием совместной плотности, то искомая плотность вероятностей

Pz(y)= ^Pz.xiy, a)da = JРх,у(а’ У—a)da.

(2.87)

Формула (2 87) выражает функцию плотности вероятностей z

через совместную плотность вероятностей х и у.

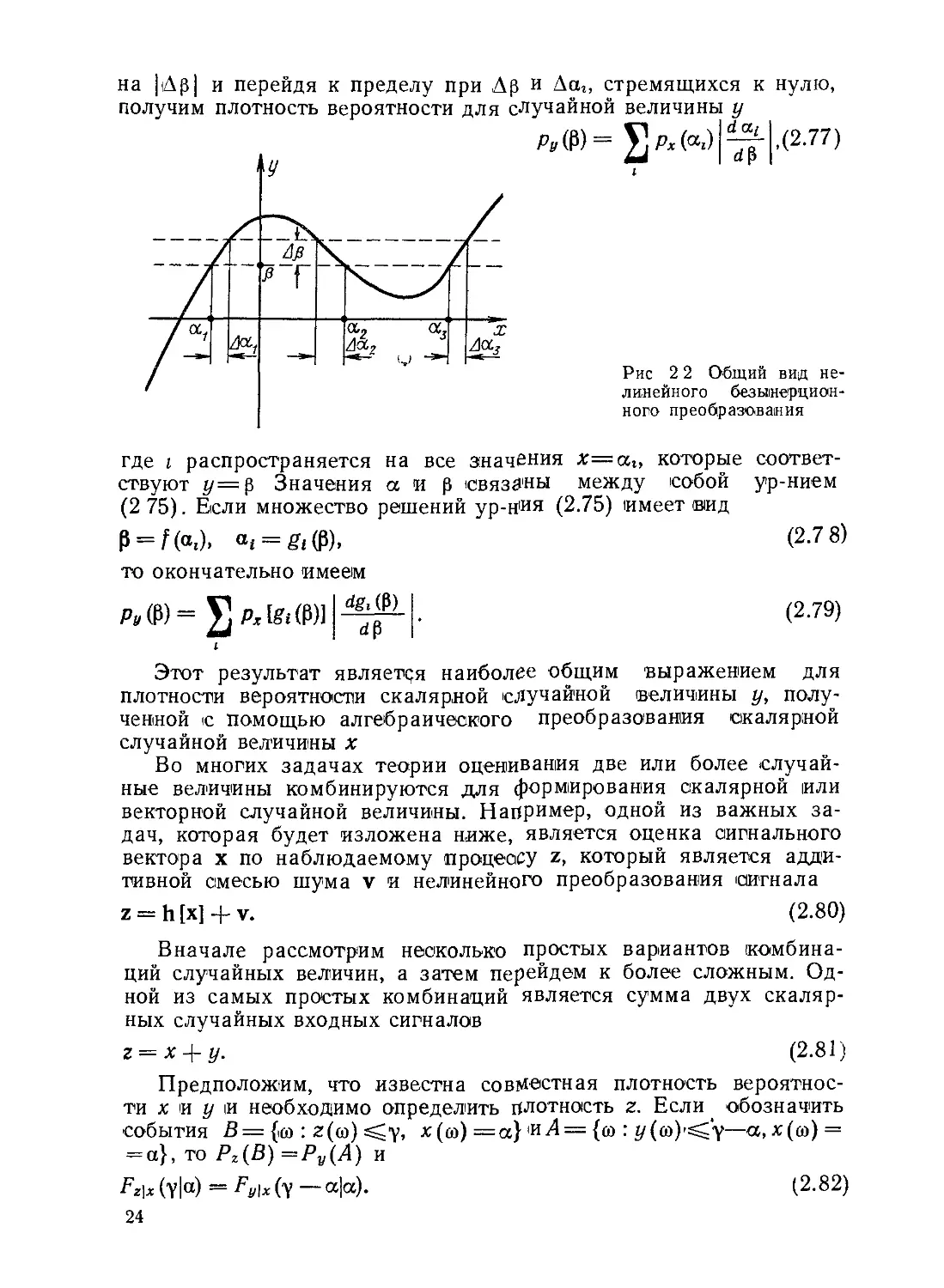

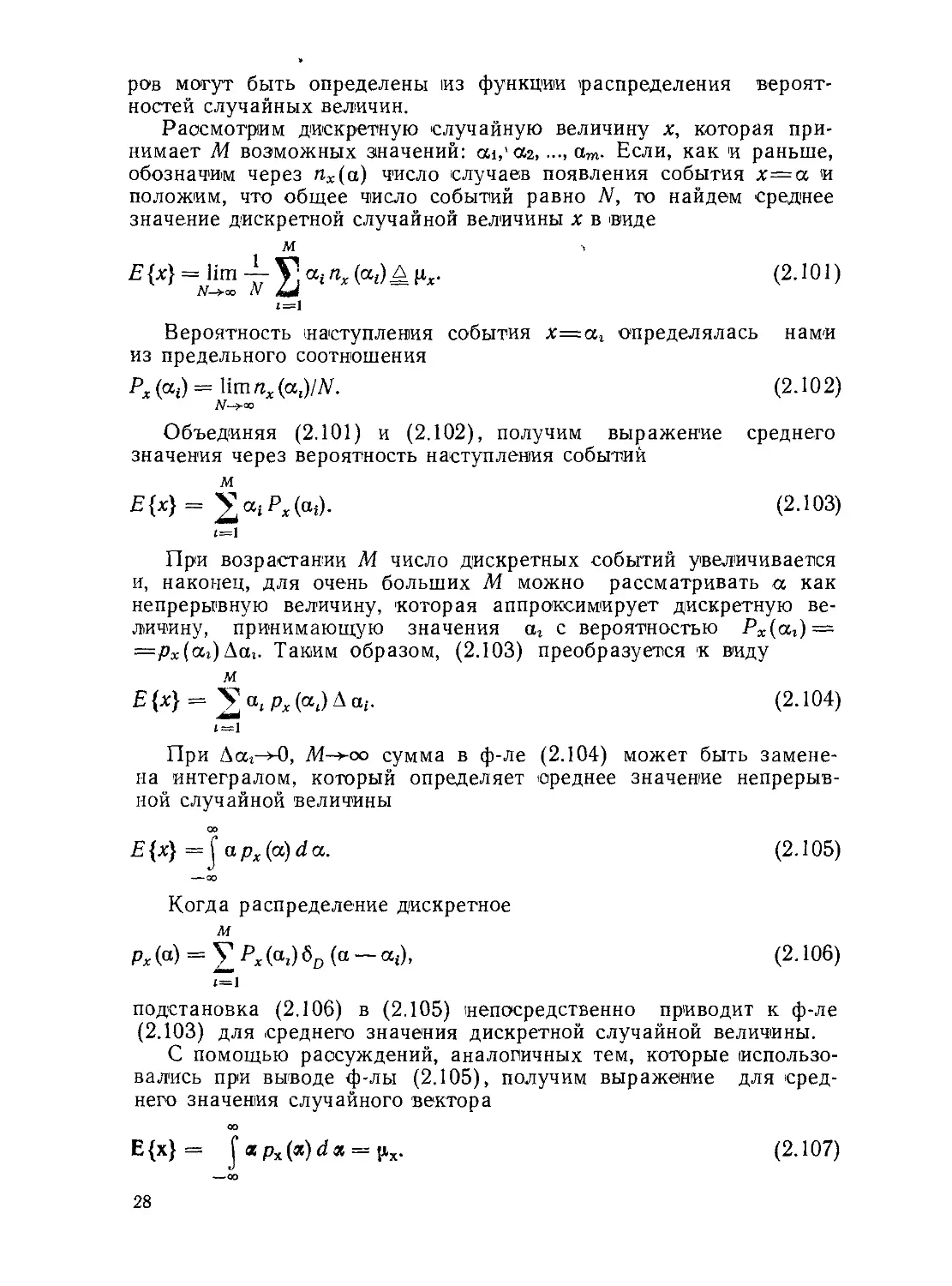

Возможен и иной метод получения этого результата при дру-

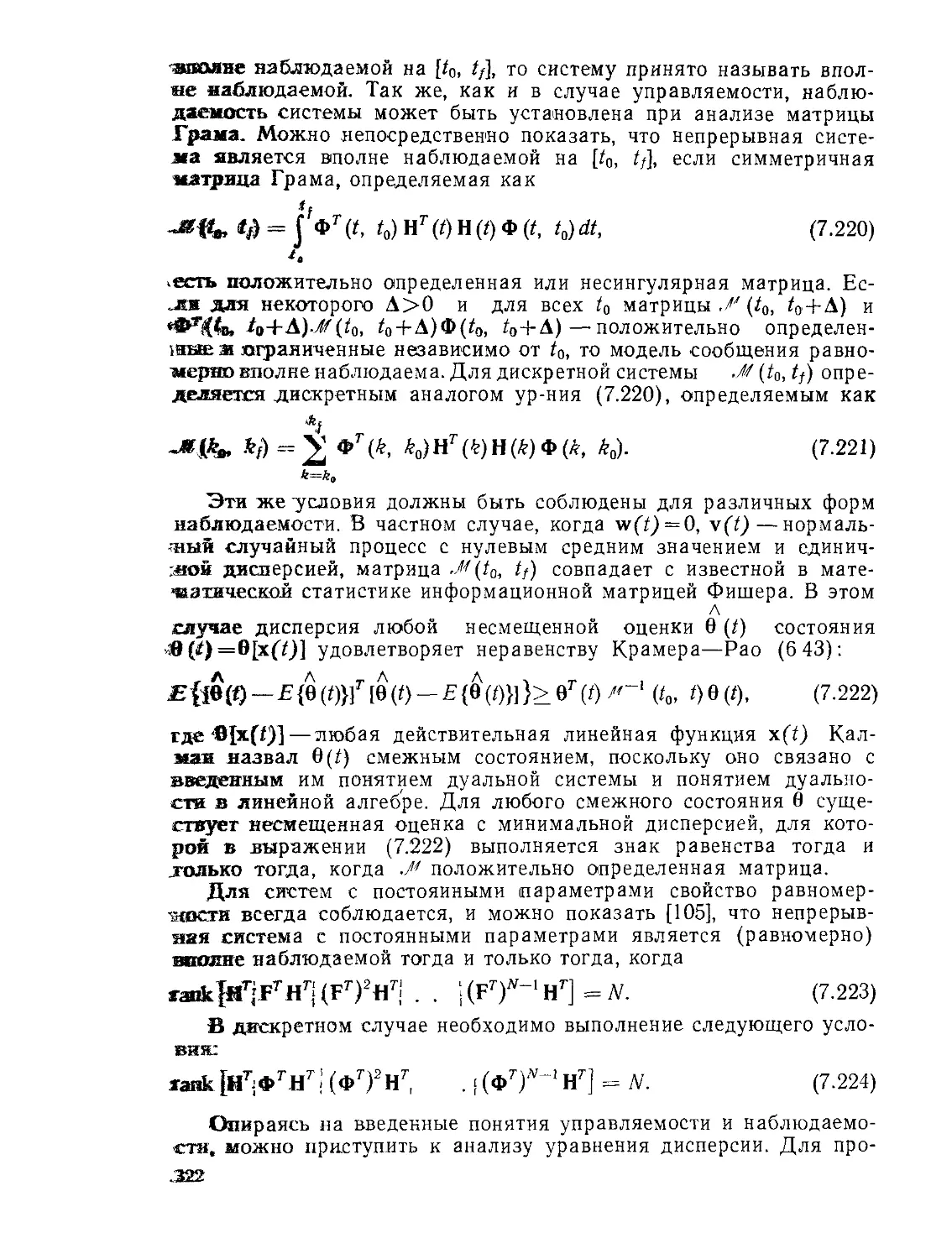

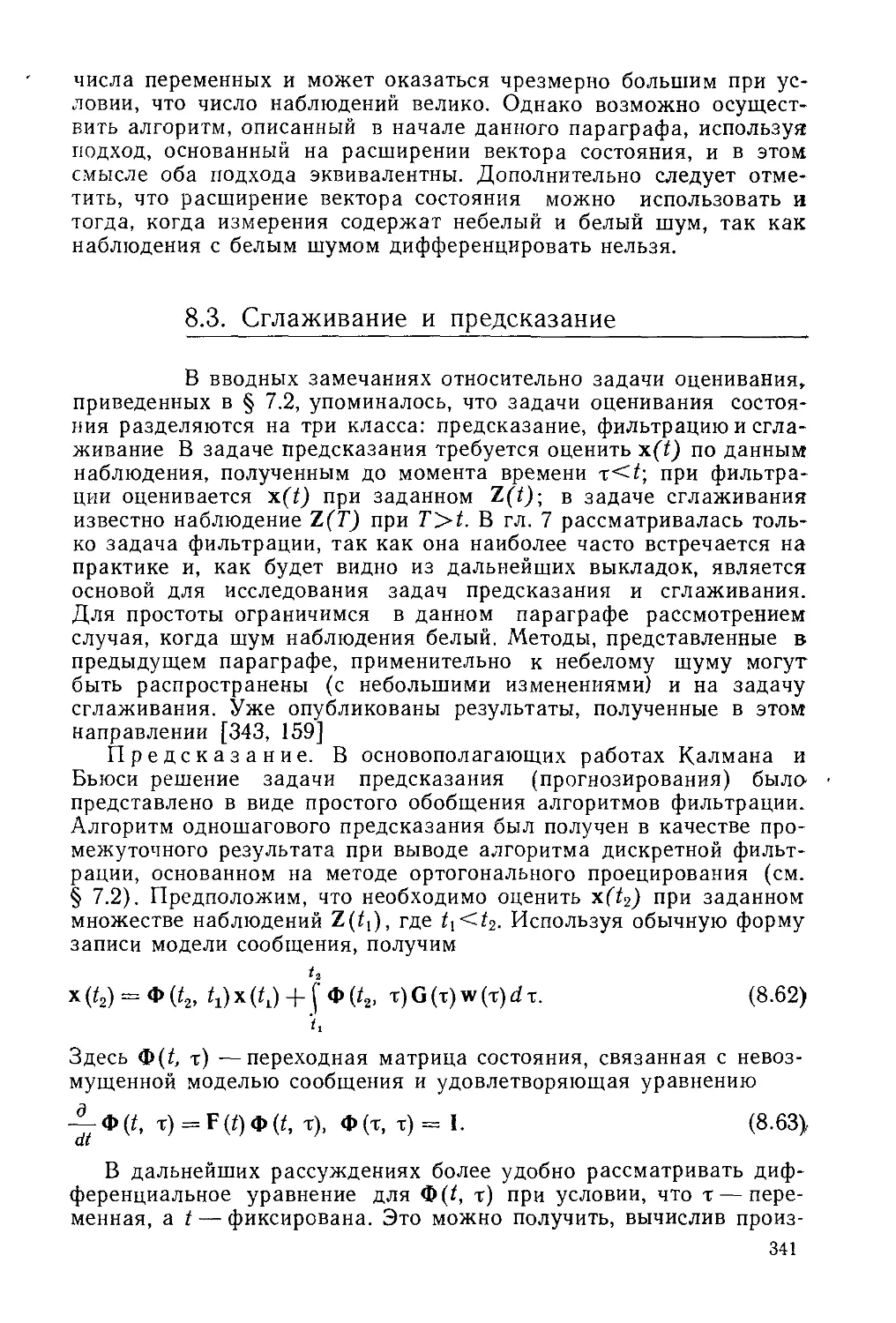

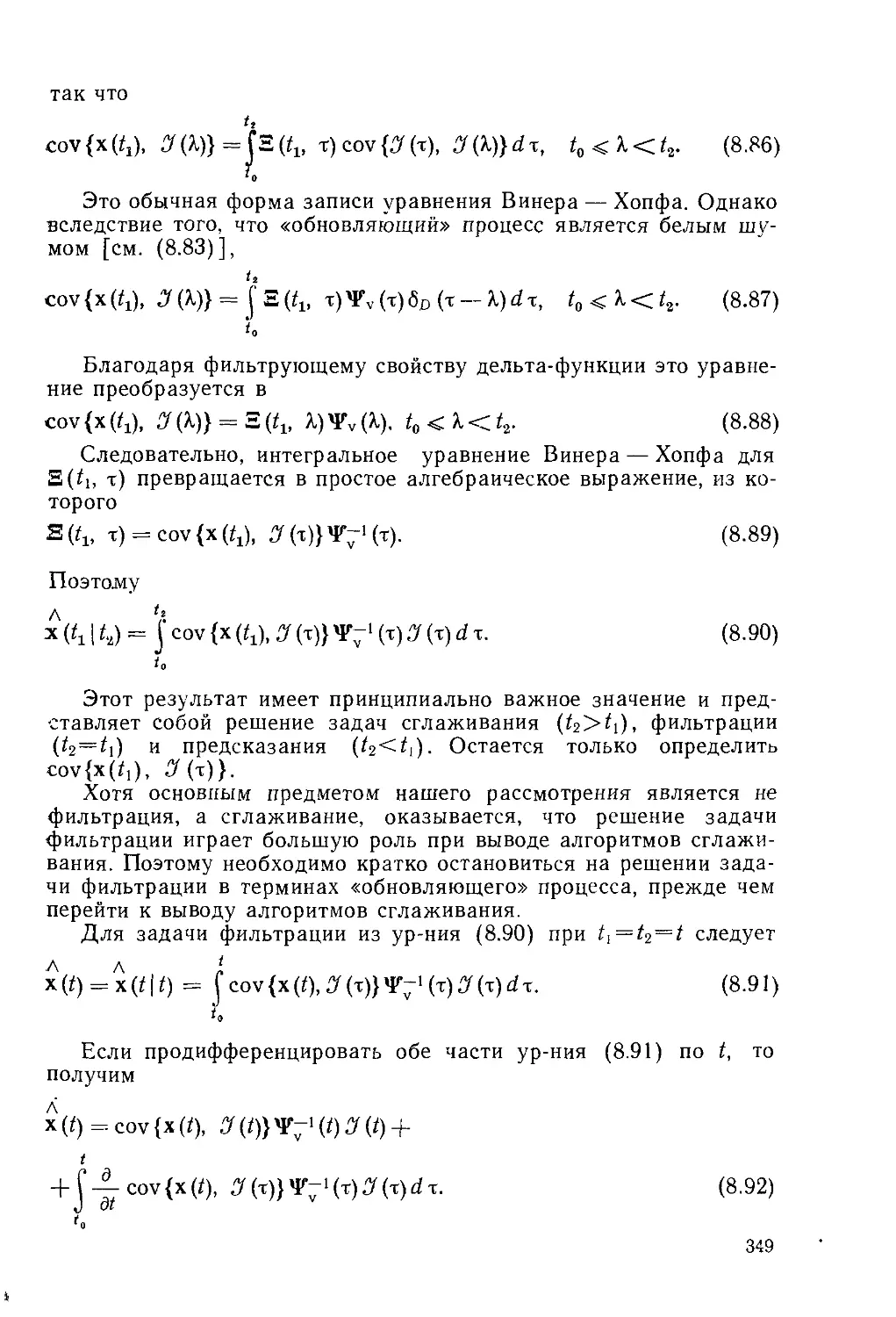

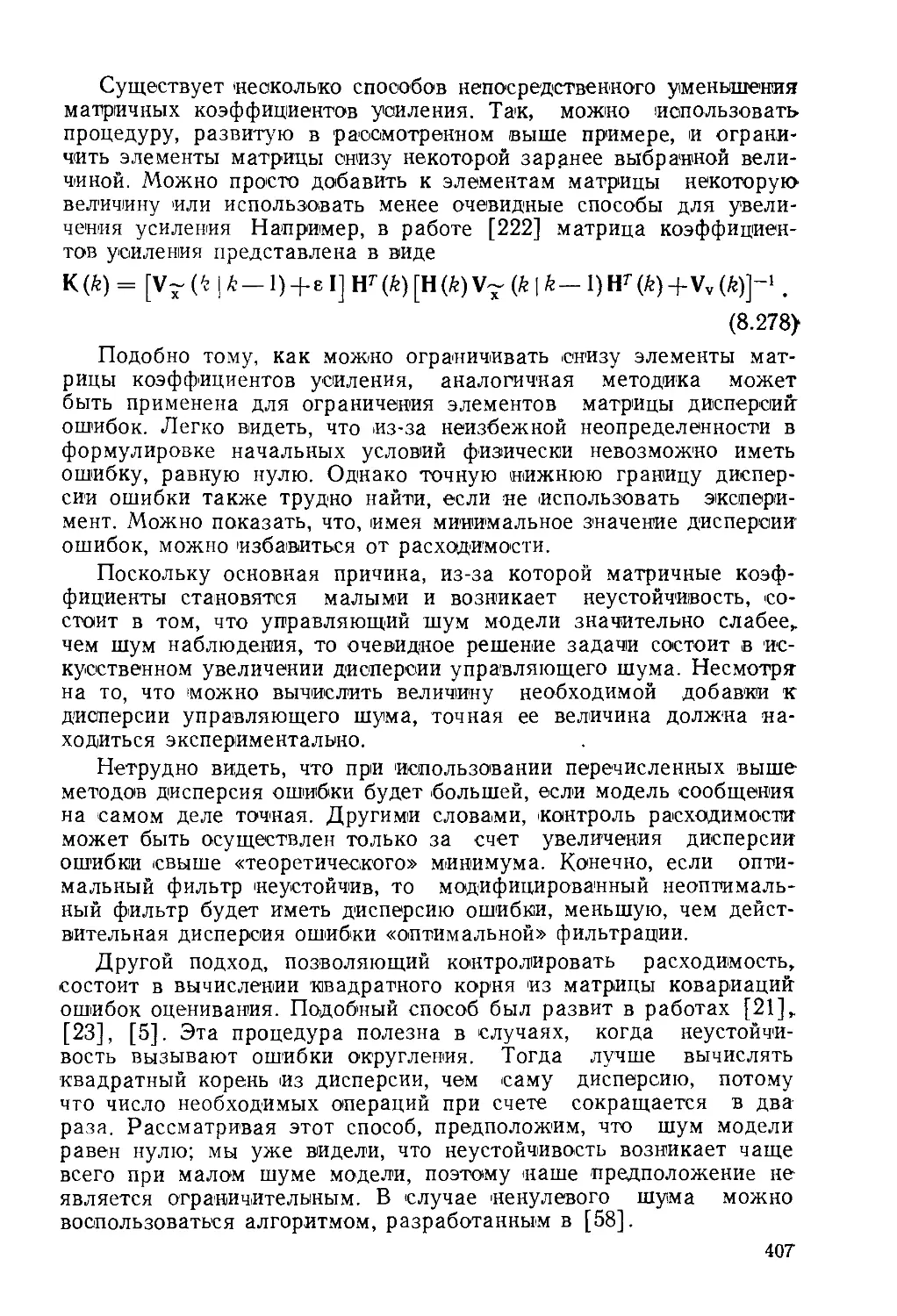

гом подходе к решению таких задач Вероятность того, что z

меньше некоторой величины у, эквивалентна тому, что все значе-

ния х и у лежат слева от линии х+у—у, как это показано на

рис 2 3. Для определения этой вероятности рассмотрим вероят-

ность попадания в полосу шириной da всех значений у от г/=—оо

до у—у—а.

V—a

J Рх.у (a, b)db

da.

25

Для получения искомой функции распределения Fz(y) следует

проинтегрировать последнее выражение по а от —оо до оо:

Ft(y) = [ J Рх,и(а< tydbda. (2.88)

—-со -00

Дифференцируя (2.89), получим функцию плотности вероят-

ности

Рх (у) = [ Рх.и (а, у — а) d а. (2.89)

— 00

Это же выражение может быть записано иначе:

Pz(y) = 1 Рх.у (У — ₽- PW- (2-90)

—<ээ

Если случайные величины х и у статистически независимы, из

ф-лы (2.90) получаем

оо оо

рг(у) = px(Y — JPx(a)P^(Y — a)da, (2-91)

-00 -00

т. e. Pz(y) представляет собой свертку двух функций плотности

вероятности.

Если z=x+y, где х и у независимы, то с помощью ур-ния

(2.91) можно вычислить рх(у)- Аналогично, если u=iz + w, где z

и w независимы, можно получить, используя (2.91) следующее

выражение для плотности вероятности случайной величины

V = w + x + y.

pv(v)= J pw(.y)pz(v— y)dy = JJ pw(y)pv$)px(y — Y — 0)d0dy.

— 00 —00

(2.92)

Рассмотрим теперь общий метод определения плотностей ве-

роятности для комбинаций случайных величин. Рассмотрим век-

торную A-мерную случайную величину у, полученную из вектор-

ной А-мерной случайной величины х с помощью векторного пре-

образования

y = f(x), (2.93)

которое является обратимым в том смысле, что обратное преоб-

разование существует и оно единственное, т. е.

x = g(y) = gH(x)]. (2.94)

Определим событие В= {<о : у(<о) ^р} и соответствующее со-

бытие А={® : f[x(<o)] ^р}=={(о : х(ш) sC*g(P)}. Вероятностные

26

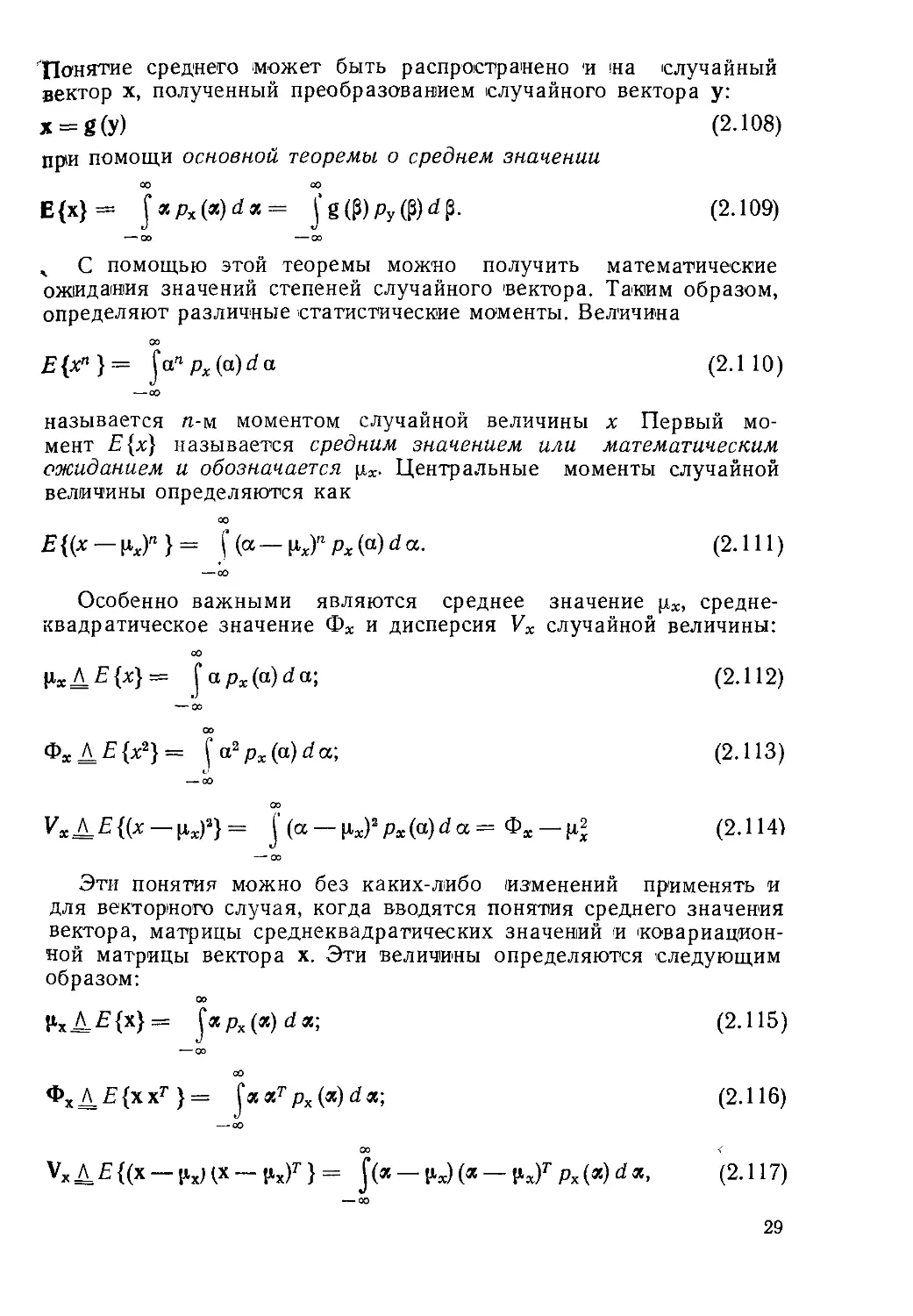

связи величин х и у определяются из равенства Ру(В)=Рх(А),

которое можно записать через функции распределения Fy (₽) = Fx [g (₽)] или через интегралы от плотностей: (2.95)

₽ g (₽) Jpy(b)db= J px(a)da. — 00 Со (2.96)

Если продифференцировать кратные интегралы по каждой из

компонент р, то, как легко убедиться, получим

ру(₽)= |det[^]|px[g(P)J. (2.97)

Здесь dg(p)/dp представляет матрицу размера NXN, элемент

которой равен dgi Таким образом,

dgi J>gL_ dgl

д Pi д р2 ’ ’ ’ д Pw

dg (Р)

. Зр .

dg2 dg2 dg2

api ap2 ” apw

(2.98)

dgN dgN dgN

_a₽i ap2 apw

и det[dg(P)/dp]—определитель матрицы (его часто называют

якобианом преобразования/). Символ |det[dg(P)/dp]| обозна-

чает абсолютную величину якобиана преобразования.

Другой метод доказательства ф-лы (2.97) получим путем за-

мены переменной в (2.96):

a = g(r); da =

detp^>

L д'г

d у.

(2.99)

Тогда ф-ла (2.96) принимает вид

В В

\py(b)db= C detMpil px[g(Y)]dy.

J JI L d X JI

--00 00

Дифференцирование этого кратного интеграла по каждой состав-

ляющей р непосредственно приводит к ф-ле (2.97). Эту формулу

будем часто использовать в дальнейшем.

2.5. Средние значения

В предыдущих разделах рассматривались понятия ве-

роятности, плотности вероятностей и функции распределения ве-

роятностей для одной и более чем одной случайной величины. Мы

видели, что вероятности соответствуют относительным частотам

появления событий и не удивительно поэтому, что средние значе-

ния (математические ожидания) случайных величин или векто-

27

ров могут быть определены из функции распределения вероят-

ностей случайных величин.

Рассмотрим дискретную случайную величину х, которая при-

нимает М возможных значений: ai.'cte, ..., От- Если, как и раньше,

обозначим через пх(а) число случаев появления события х=а и

положим, что общее число событий равно N, то найдем среднее

значение дискретной случайной величины х в виде

М >

Е{х} = Ит-^-У]аг^(аг)Д (2.101)

w->oo V Xj

г=1

Вероятность наступления события х=аг определялась нами

из предельного соотношения

px(ai)= Ит/гх(аг)Ж (2.102)

>-О0

Объединяя (2.101) и (2.102), получим выражение среднего

значения через вероятность наступления событий

м

Е{х}= £агРх(аг). (2-103)

г=1

При возрастании М число дискретных событий увеличивается

и, наконец, для очень больших М можно рассматривать а как

непрерывную величину, которая аппроксимирует дискретную ве-

личину, принимающую значения аг с вероятностью Рх(аг} —

=Рх(аг)Ааг. Таким образом, (2.103) преобразуется к виду

м

Е W = 2 Рх А а'1' (2.104)

<=1

При Даг->4), Л4->-оо сумма в ф-ле (2.104) может быть замене-

на интегралом, который определяет среднее значение непрерыв-

ной случайной величины

Е {х} = J а рх (a) d а. (2.105)

-00

Когда распределение дискретное

м

Px(a) = X/’x(az)6D(a —aj), (2.106)

подстановка (2.106) в (2.105) непосредственно приводит к ф-ле

(2.103) для среднего значения дискретной случайной величины.

С помощью рассуждений, аналогичных тем, которые использо-

вались при выводе ф-лы (2.105), получим выражение для сред-

него значения случайного вектора

00

Е{х} = J а px(a) d я = рх. (2.107)

28

'Понятие среднего может быть распространено и на случайный

вектор х, полученный преобразованием случайного вектора у:

x = g(y) (2.108)

при помощи основной теоремы о среднем значении

оо со

Е{х}= J «рх(я) d х = Jg(₽)py(₽)d₽. (2.109)

--00 —00

ч С помощью этой теоремы можно получить математические

ожидания значений степеней случайного вектора. Таким образом,

определяют различные статистические моменты. Величина

£{xn}= ^anpx(a)da (2.110)

-—со

называется п-м моментом случайной величины х Первый мо-

мент Е{х} называется средним значением или математическим

ожиданием и обозначается рж- Центральные моменты случайной

величины определяются как

00

£{(* —Их)"}= J(a—Hx)"Px(“)da- (2.111)

— со

Особенно важными являются среднее значение средне-

квадратическое значение Фж и дисперсия Vx случайной величины:

ржД£{х} = Japx(a)da; (2.112)

--00

ФхД£{х2} = ^a2px(a)da; (2.113)

—•со

00

VxJ^E{(x — рх)3} = J(a — ц,х)2 px(a)da= Фя — р2 (2.114)

— 00

Эти понятия можно без каких-либо изменений применять и

для векторного случая, когда вводятся понятия среднего значения

вектора, матрицы среднеквадратических значений и 'ковариацион-

ной матрицы вектора х. Эти величины определяются следующим

образом:

НхД£{х}= У«рх(«)^зс; (2.115)

— оо

Фх Д Е {х хг } = ^ххт px(x)dx; (2.116)

— со

00 <

УхД£{(х —рхцх —pxf} = J(« — Ь)(« — у.х)т px(x)dx, (2.117)

-----------------------------00

29

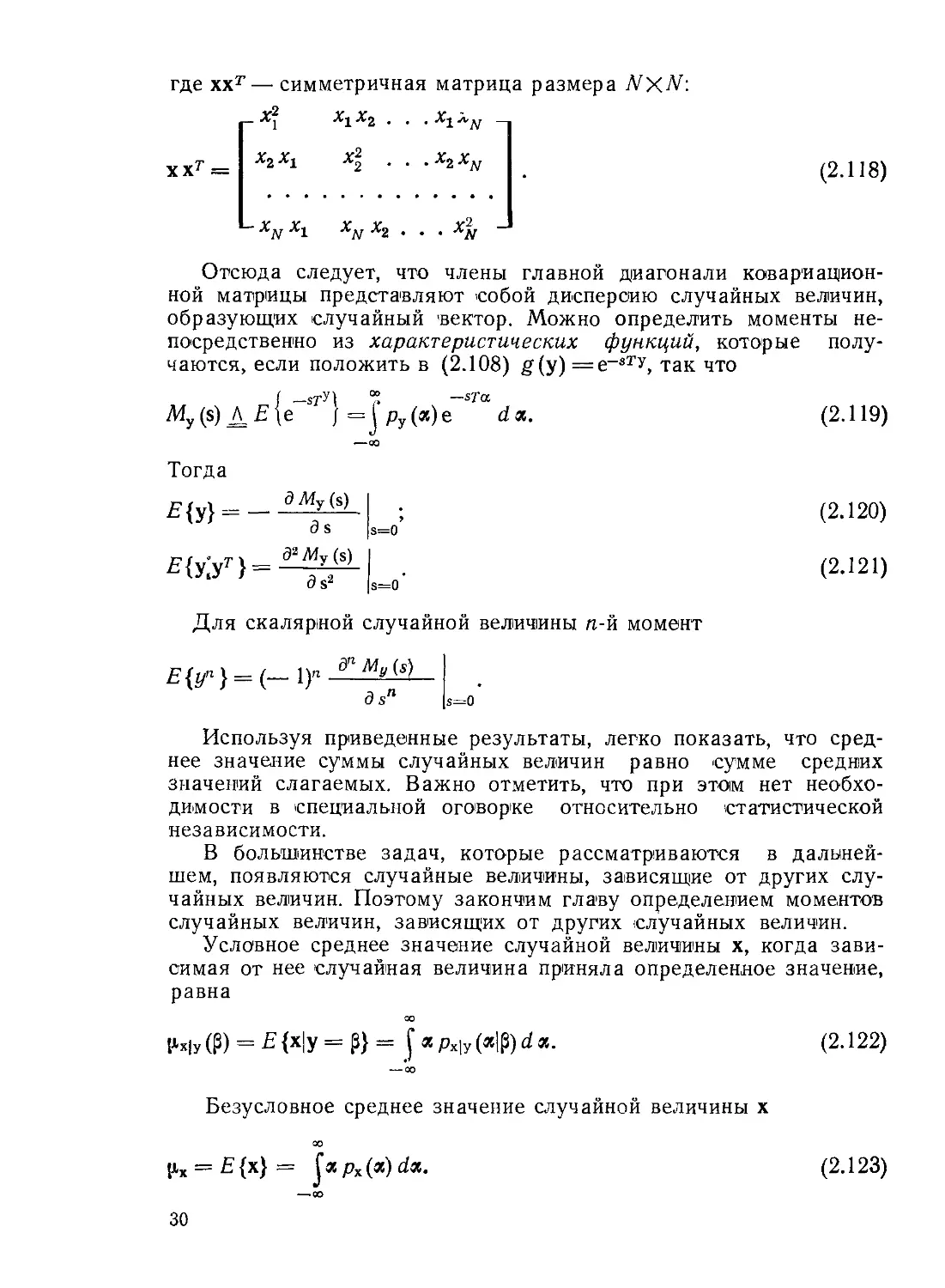

где ххт— симметричная матрица размера jVxM:

ххх2

х2

Л2

•X1XN ~

X2XN

(2.118)

~ XN Х1 XN Х2 • • • XN

Отсюда следует, что члены главной диагонали ковариацион-

ной матрицы представляют собой дисперсию случайных величин,

образующих случайный вектор. Можно определить моменты не-

посредственно из характеристических функций, которые полу-

чаются, если положить в (2.108) g(y)=e~sTy, так что

[ —ST?) “ — sTa

My(s)^E\e J = I ру(зс)е da. (2.119)

-QO

Тогда

(2.120)

(2.121)

Для скалярной случайной величины n-й момент

E{tf } = (— 1)" — Му (s)—

dsn

s—Q

Используя приведенные результаты, легко показать, что сред-

нее значение суммы случайных величин равно сумме средних

значений слагаемых. Важно отметить, что при этом нет необхо-

димости в специальной оговорке относительно статистической

независимости.

В большинстве задач, которые рассматриваются в дальней-

шем, появляются случайные величины, зависящие от других слу-

чайных величин. Поэтому закончим главу определением моментов

случайных величин, зависящих от других случайных величин.

Условное среднее значение случайной величины х, когда зави-

симая от нее случайная величина приняла определенное значение,

равна

00

|1х|у (₽) = Е {х|у = 0} = apx\y(a\$)da. (2.122)

— 00

Безусловное среднее значение случайной величины х

00

|лх = Е {х} = Jac рх (зс) da.

—оо

(2.123)

30

Так как индивидуальная плотность вероятности рх(а). может

|ыть получена из совместной плотности рх,у(а, р), рх(а) =

= J Рх,у(а> ₽)^Р> то совместная, условная и Индивидуальная плот-

ности связаны соотношением рХгУ(а, P)=pxU, (а|Р)ру(р). Тогда

можно записать эквивалентное (2.123). выражение в виде

Е {х} = J Рау («!₽) Ру (ftdad р.

— 00

В этом выражении легко выделить условное математическое ожи-

дание (2.122). Таким образом, получим соотношение между услов-

ным и безусловным средними значениями

£{х}= j£{xjy = p}py(P)dp (2.124)

—со

или Ех{х} = Еу{ЕХ|У{х|у}}, (2.125)

где индексация используется для выделения случайной величины,

для которой находится среднее. Как правило, мы не будем ис-

пользовать индексацию моментов распределения, если только это

не будет необходимо для ясности.

Условная дисперсия х, если задан у, будет обозначаться как

var{x|y=p} или vX|y (р). Имеем

var {х|у = р} = Е {(х — Е {х| у = р}) (х — Е {х|у = р})Т |у = р} =

= J(« — £{*|У = р})(а—Е{х|у= pfpX|y (a|P)da. (2.126)

— 00

Для условных дисперсий .можно получить выражения, анало-

гичные ф-лам (2.124) и (2.125). Легко показать, что

Е {(х — Е {х}) (х — Е {х})7' |у = р} = Е {(х — Е {х| у = р}) (х —

- Е {х|у = p}f |у = р} + (Е{х| у = р} - Е{х}) (Е {х|у — р} — Е {х}Г,

(2.127)

где все символы усреднения относятся к х или к х, зависящему

от у. Если теперь рассмотреть усреднение п<) у в ур-ниях (2.127),

то получим:

Еу {Ех {(Ех {(х - Ех {х}) (х - Ех {x}f |у = Р} = varx {х};

ЕУ {Ex {(х — ЕХ|У {х|у = р}) (х — ЕХ|У {х|у = р})г }|у = Р) =

= Еу {varX|y {х|у = р}}; (2.128)

Еу{(Ех|у{х|у = р} —Ех{х})(Ех {х|у = р} — Ех{х})г } = vary {Ех,у {х|у = р}},

где введены индексы для дисперсий, чтобы Исключить возможную

путаницу. Объединив полученные результаты (с 2.127), увидим,

31

что дисперсия случайной величины х эквивалентна среднему по у

условной дисперсии х плюс дисперсия по у условного математи-

ческого ожидания х. Это утверждение можно записать следую-

щим образом:

varx{x} = Ey{varx|y{x|y= £}} + vary {£х|у{х|у = £}}. (2.129)

Определяя условную характеристическую функцию

Мс|У(^)Д£х1у{е^к|у = 0}= ^e~sTapx]y^)da, (2.130)

--00

можно использовать ее для получения различных моментов.

В частности, имеем

ОО

Mx(s) = £y{Mxly(s|₽)}=jMx|y(s|₽)py(₽)d₽. (2.131) •

Глава 3

СЛУЧАЙНЫЕ ПРОЦЕССЫ

3.1. Введение

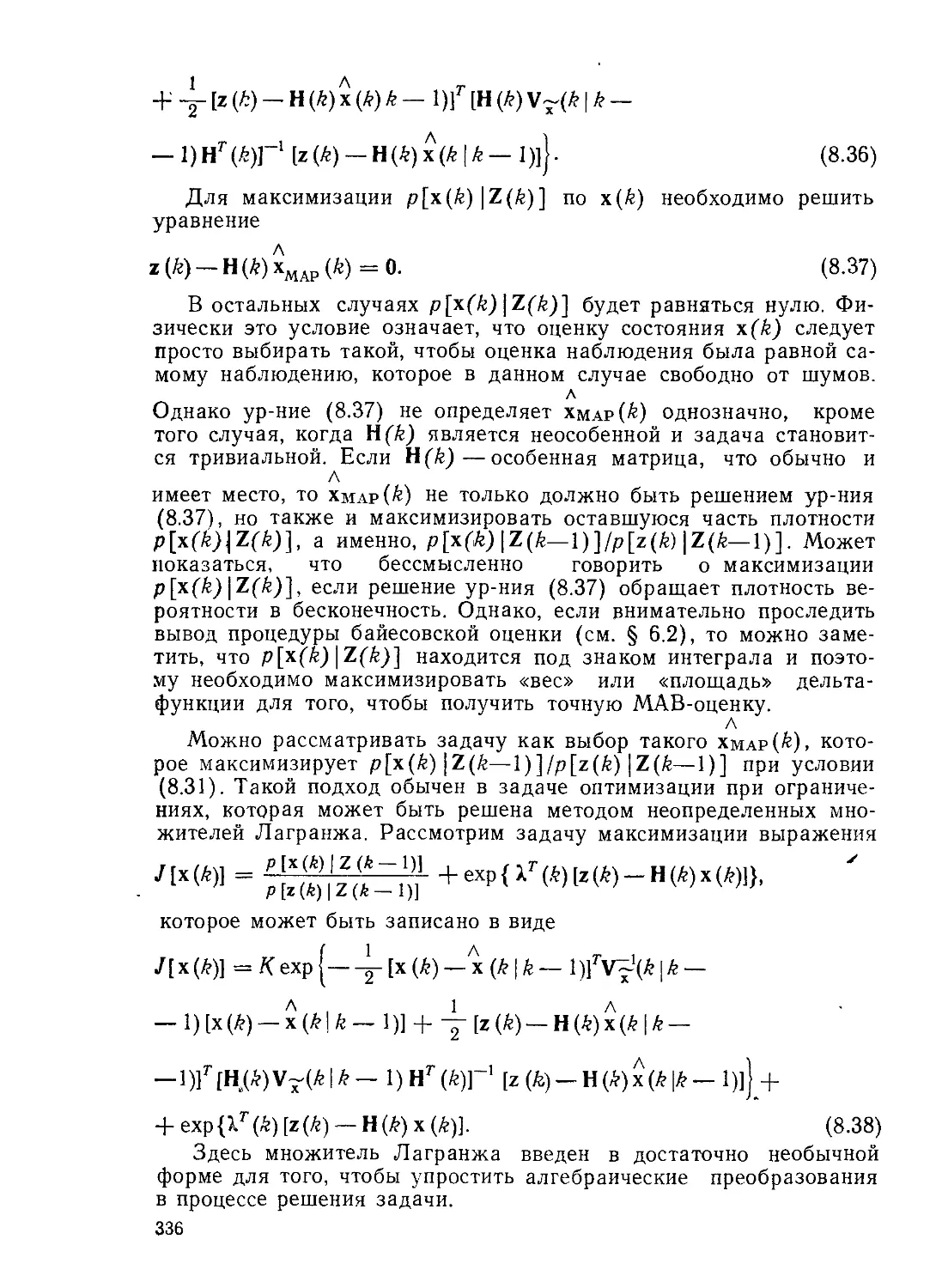

В гл. 2 символ х(а>) использовался вместо символа х

чтобы отразить тот факт, что х является случайным вектором

значение которого зависит от эксперимента со. Рассмотрение слу

чайных величин, являющихся

функциями времени, приводит

нас к изучению случайных про-

цессов. Если каждому исходу

эксперимента со поставить в

соответствие временную функ-

цию x(t, со), получим то, что в

дальнейшем будем называть

случайным процессом. На

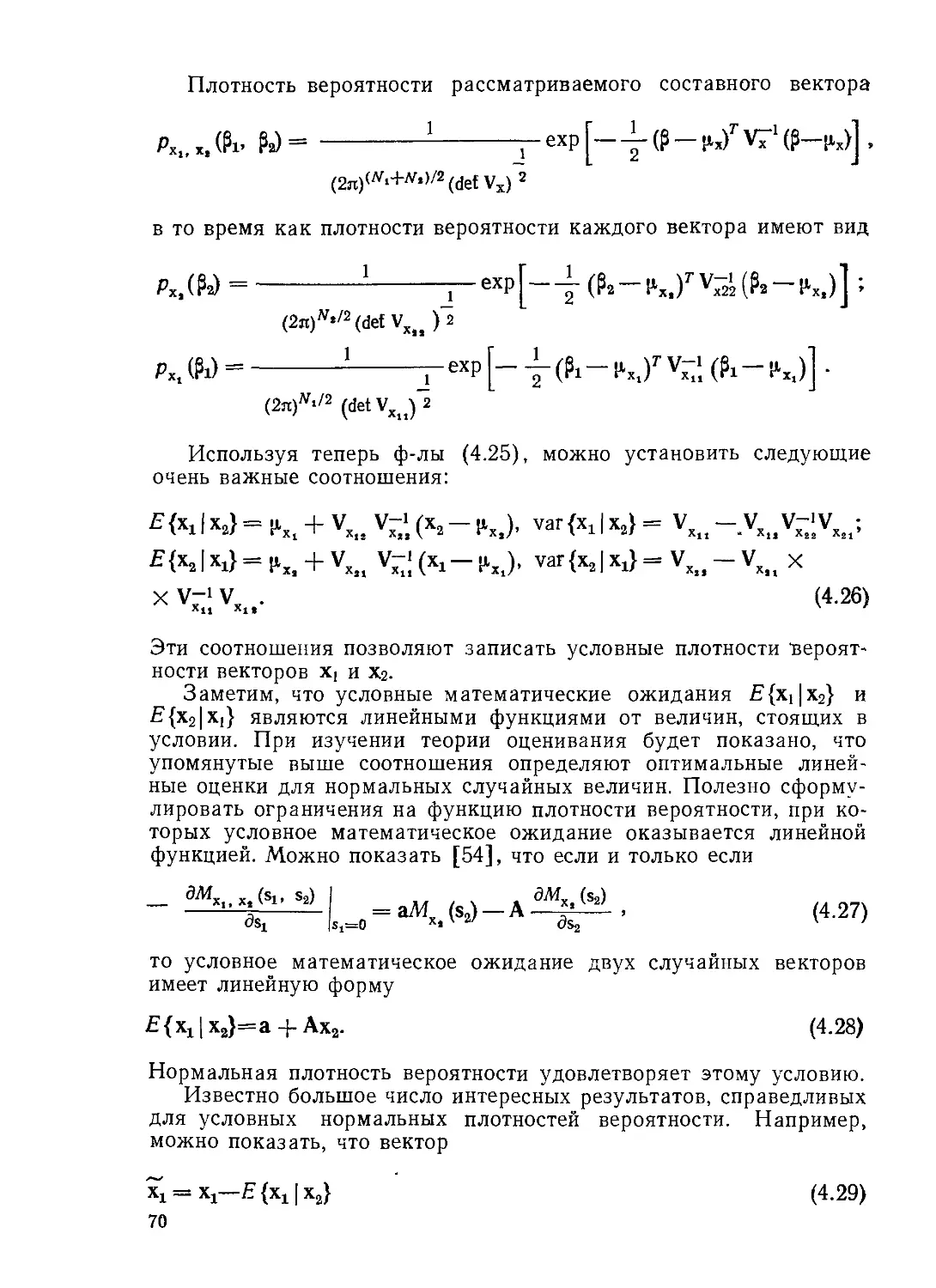

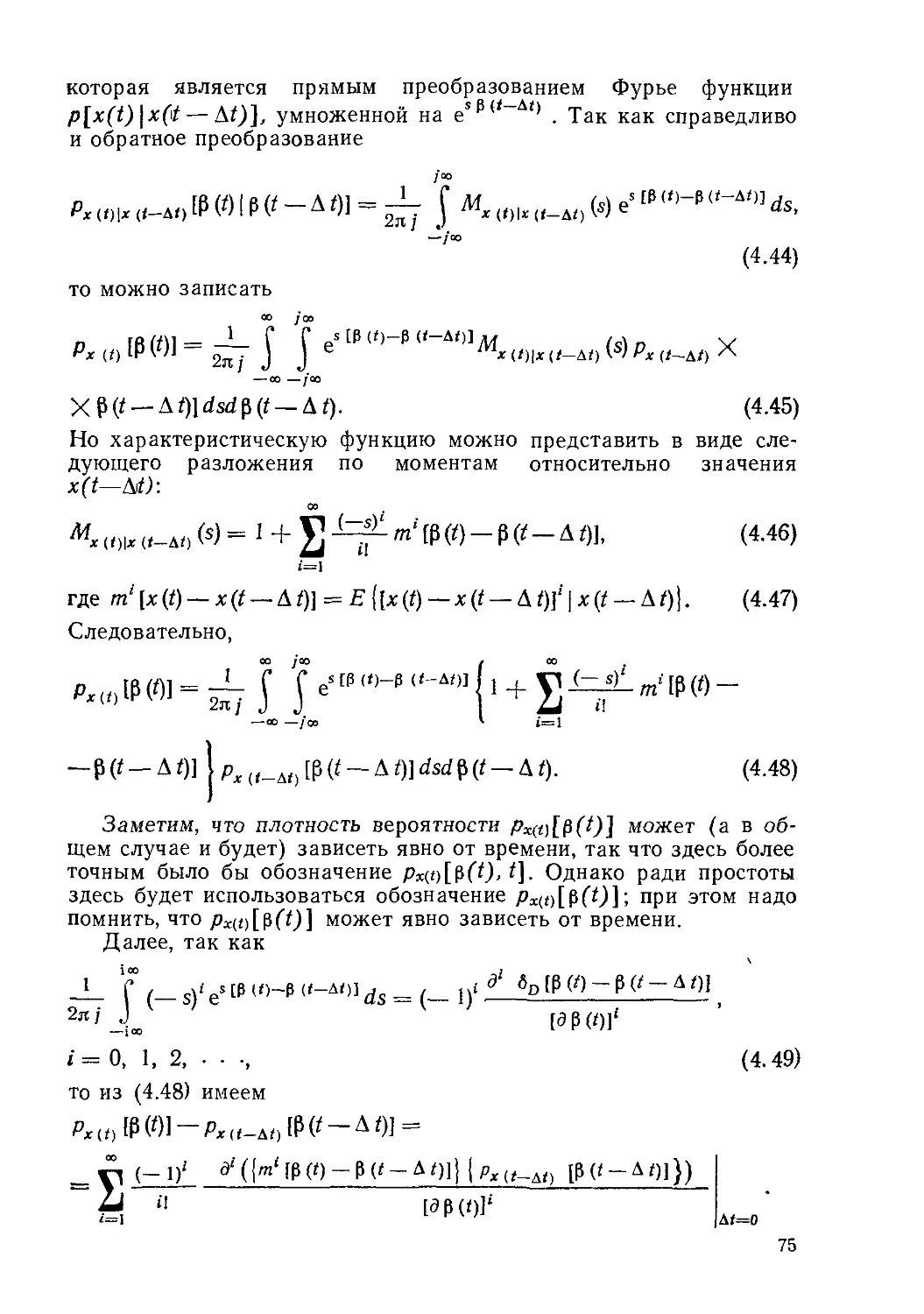

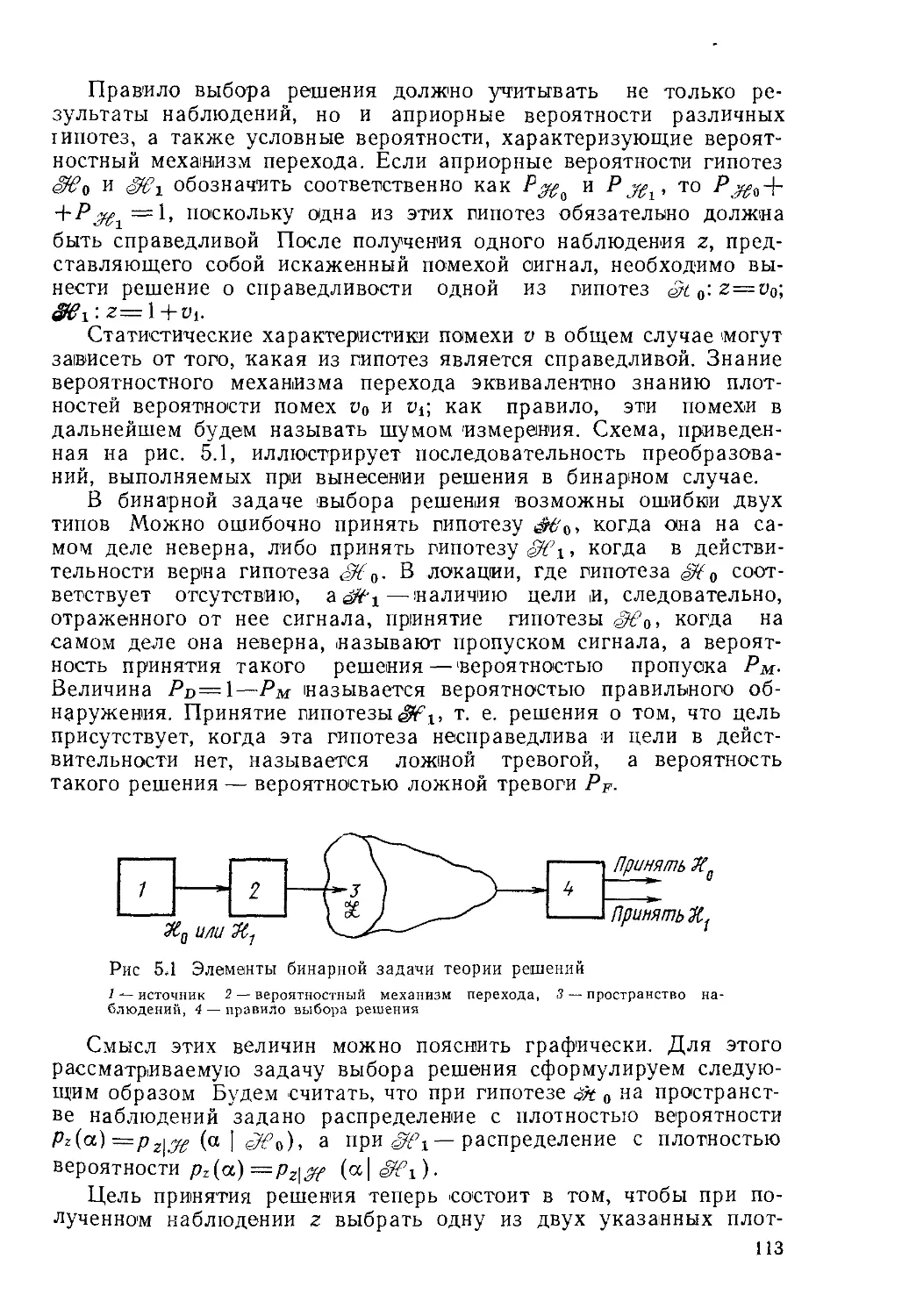

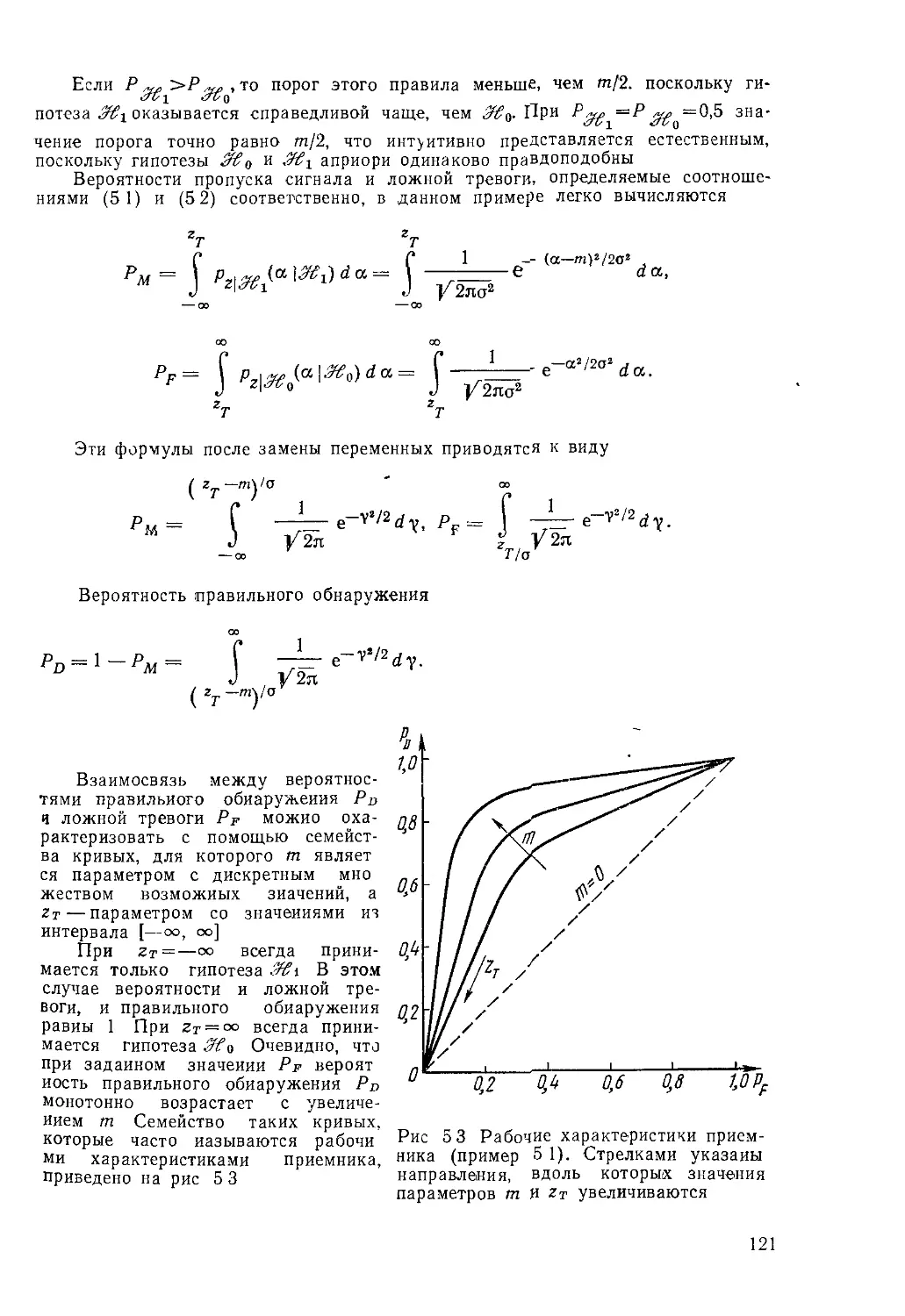

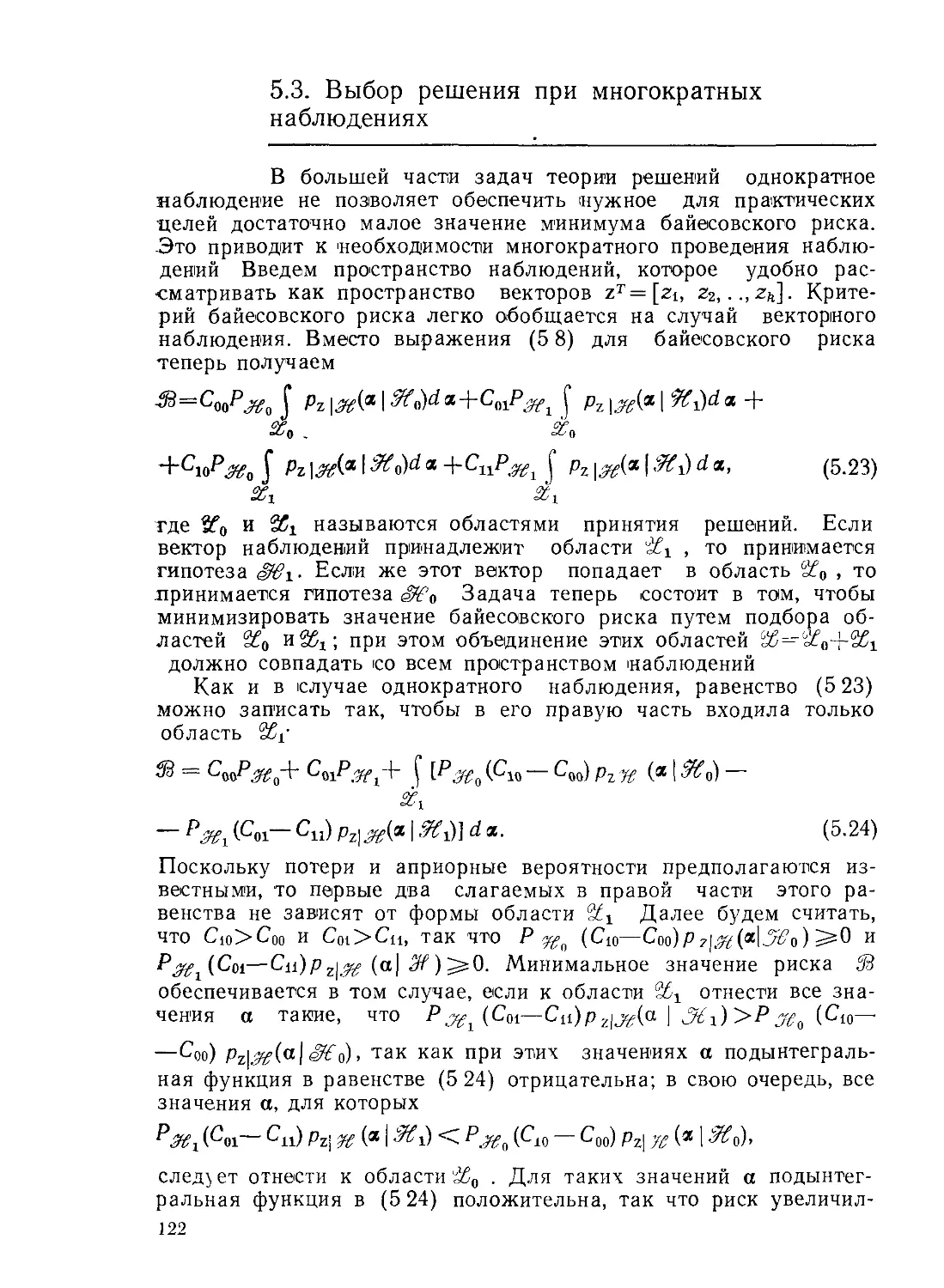

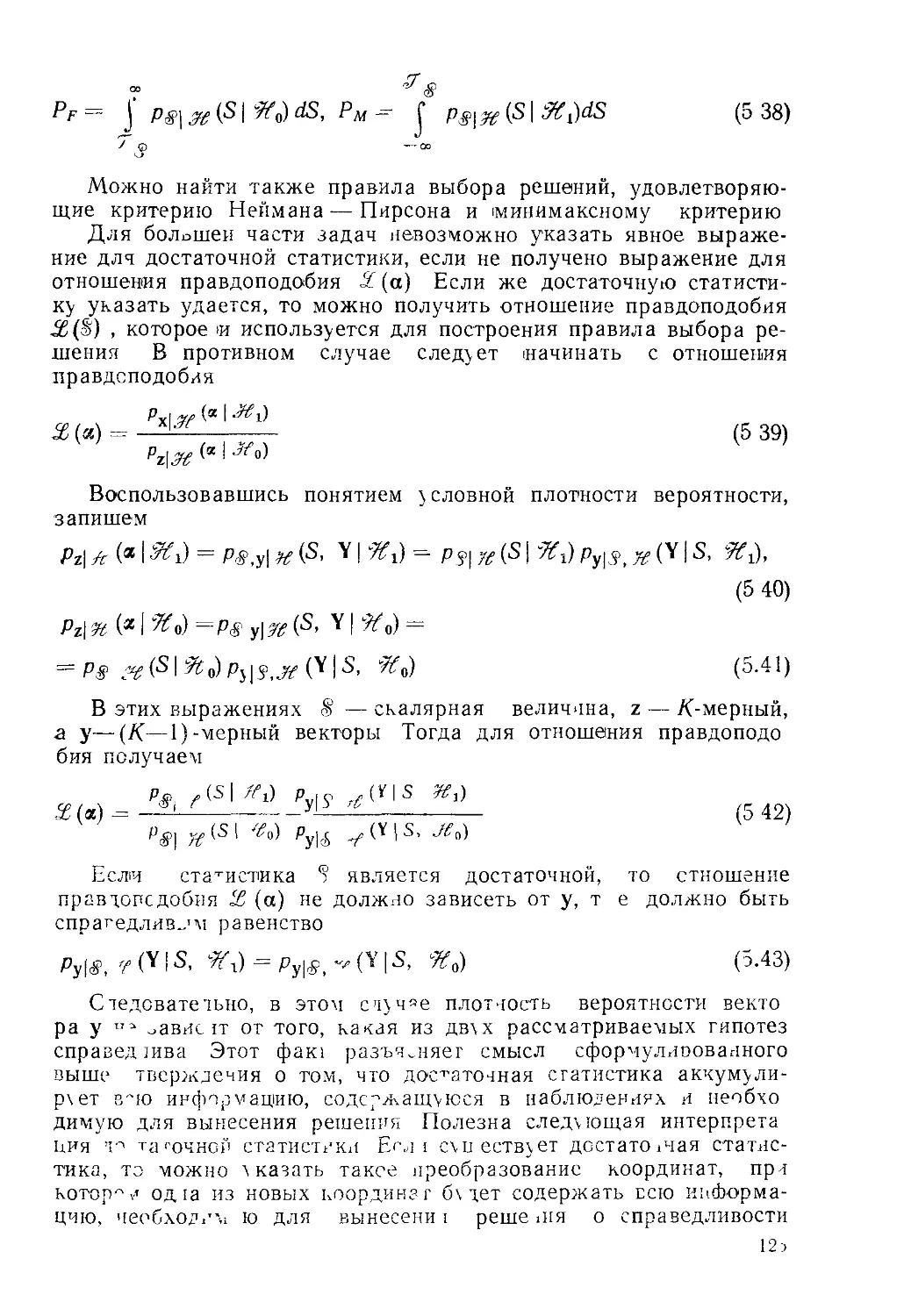

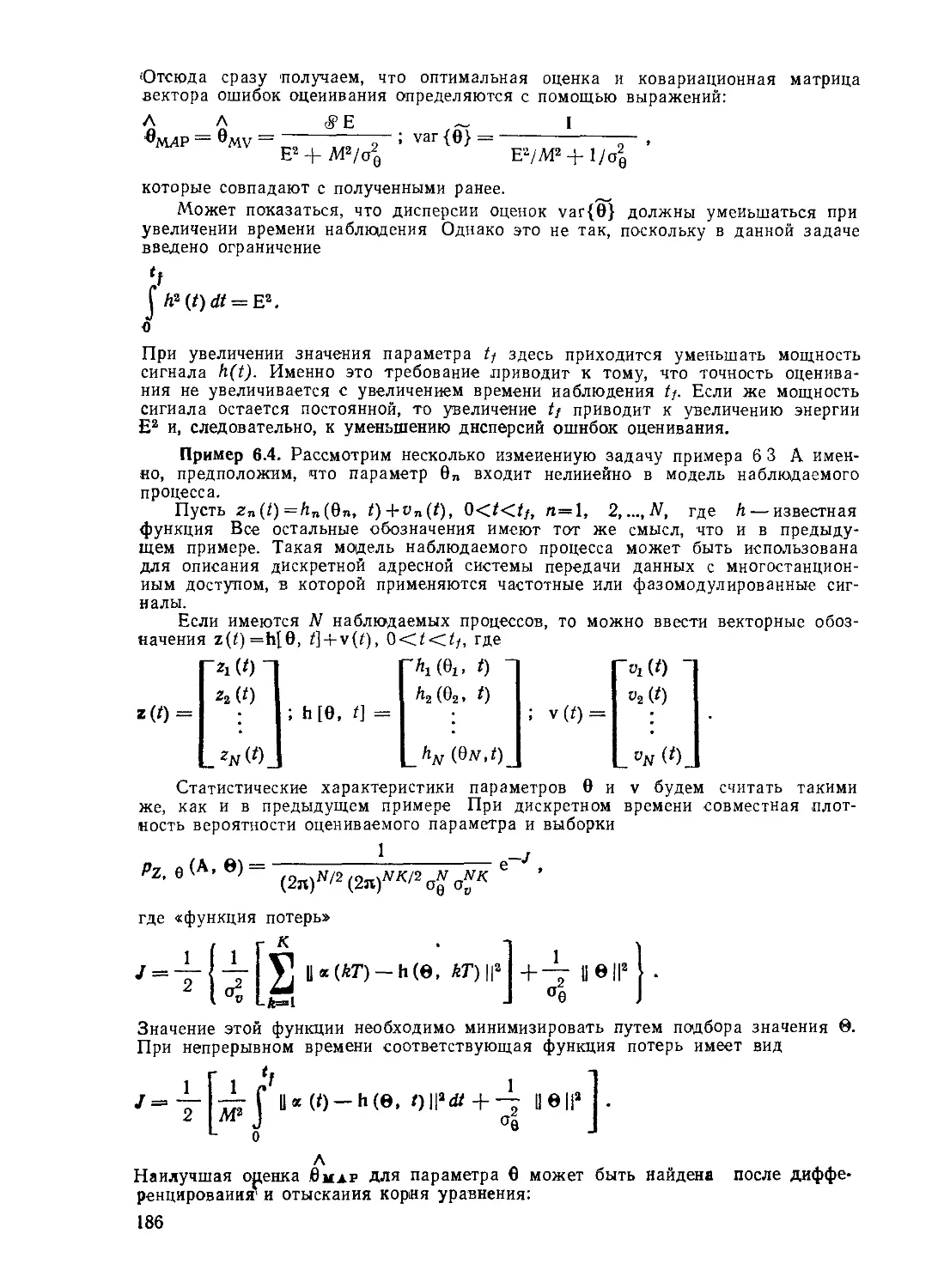

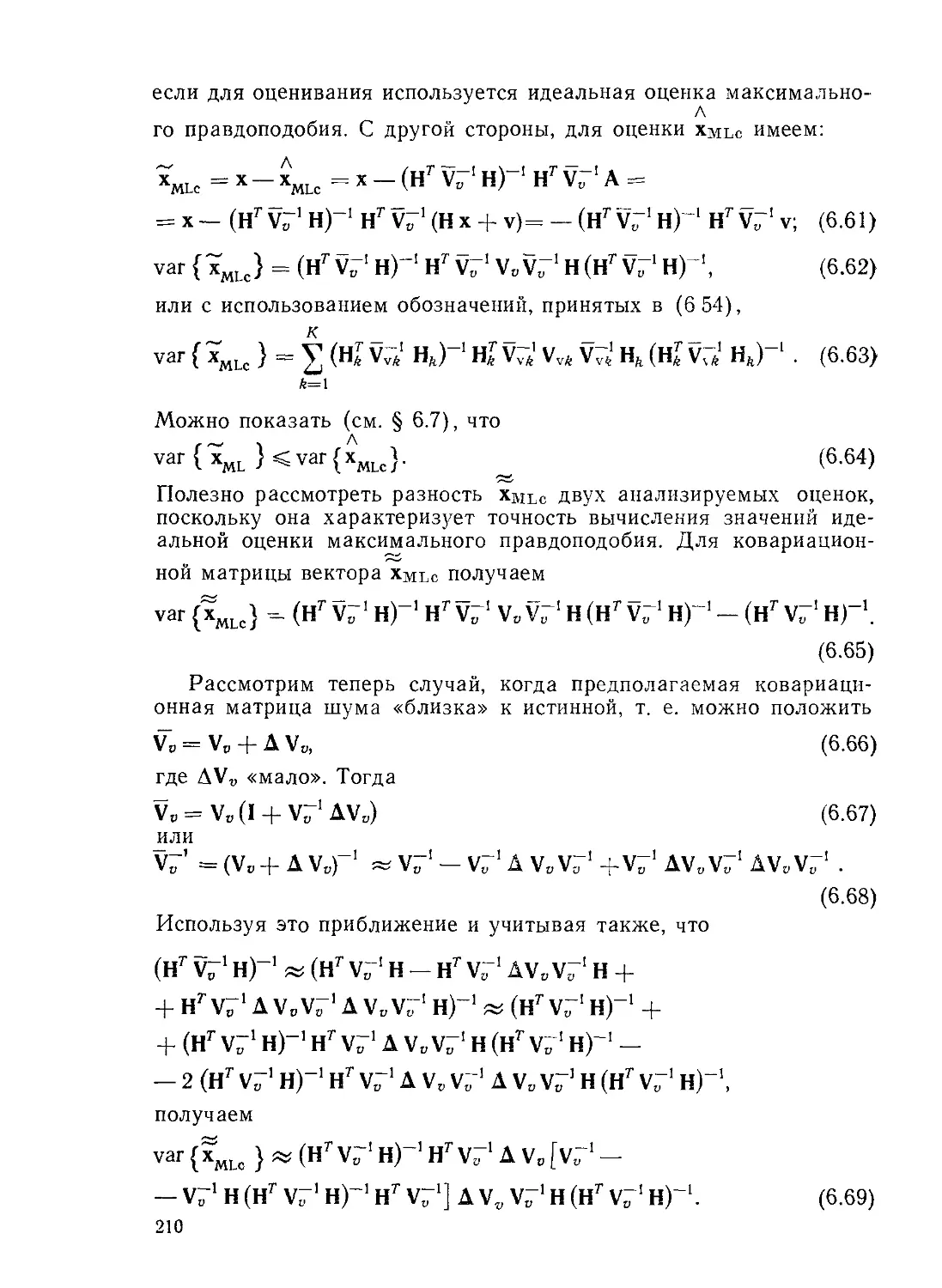

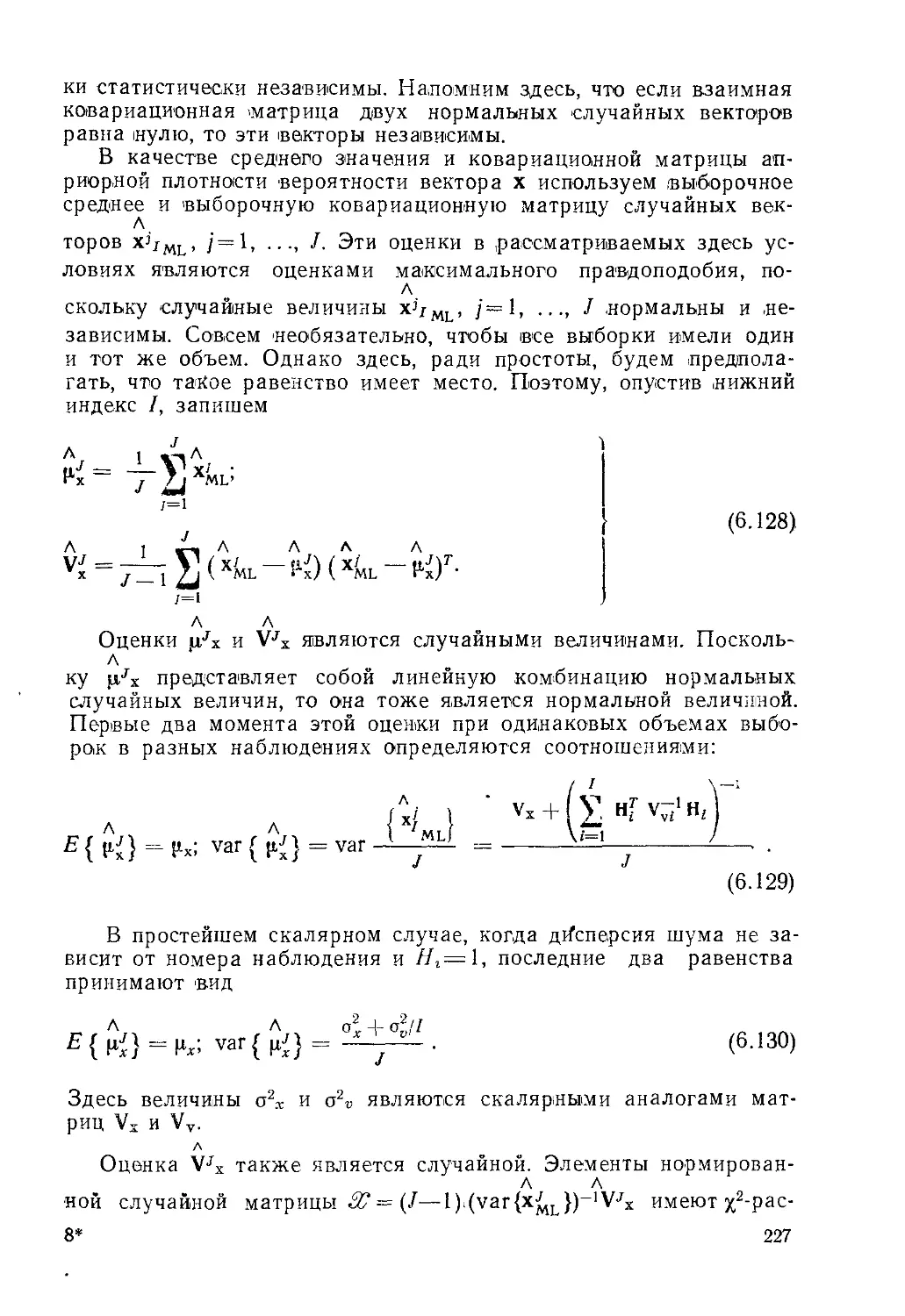

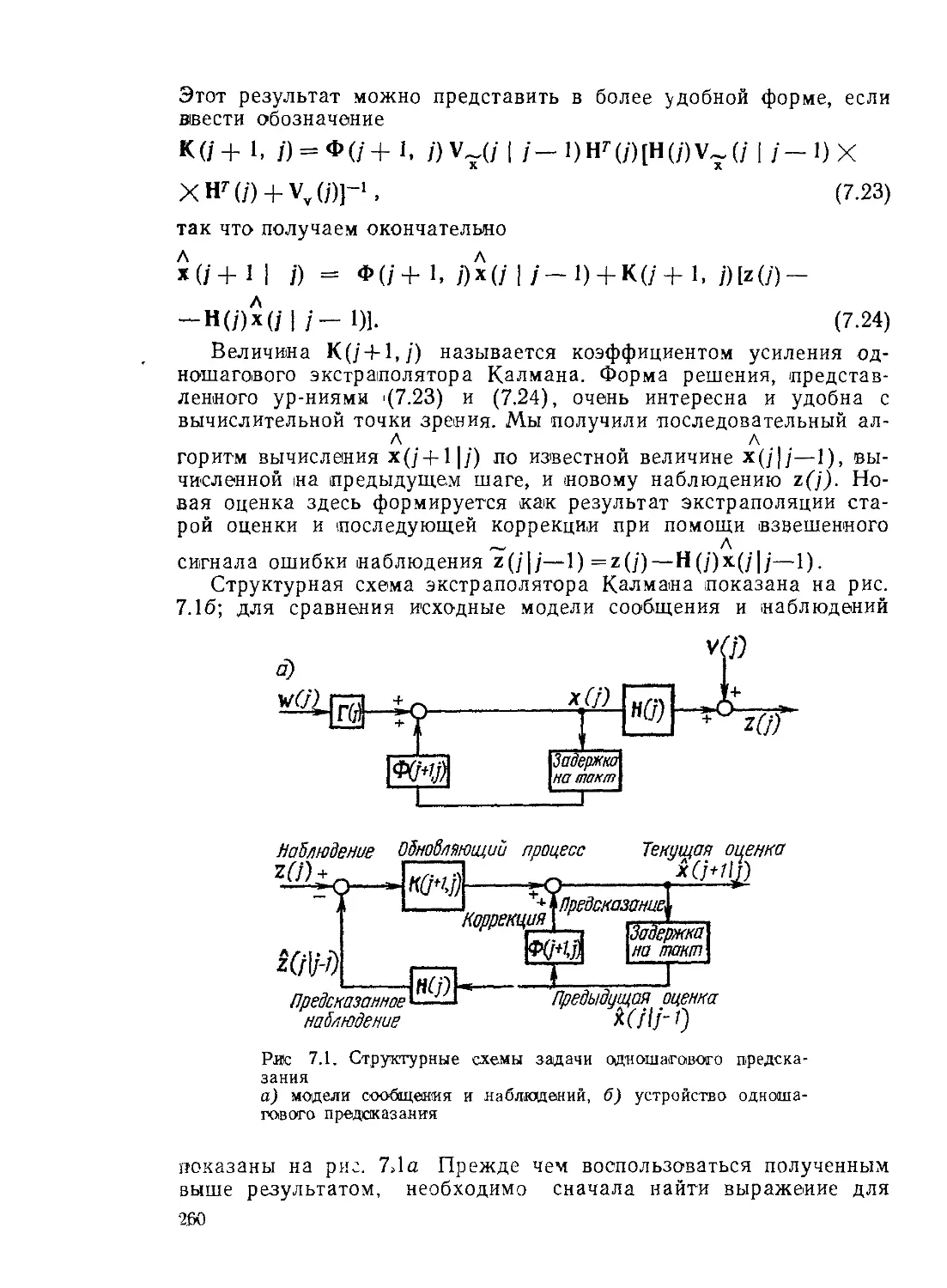

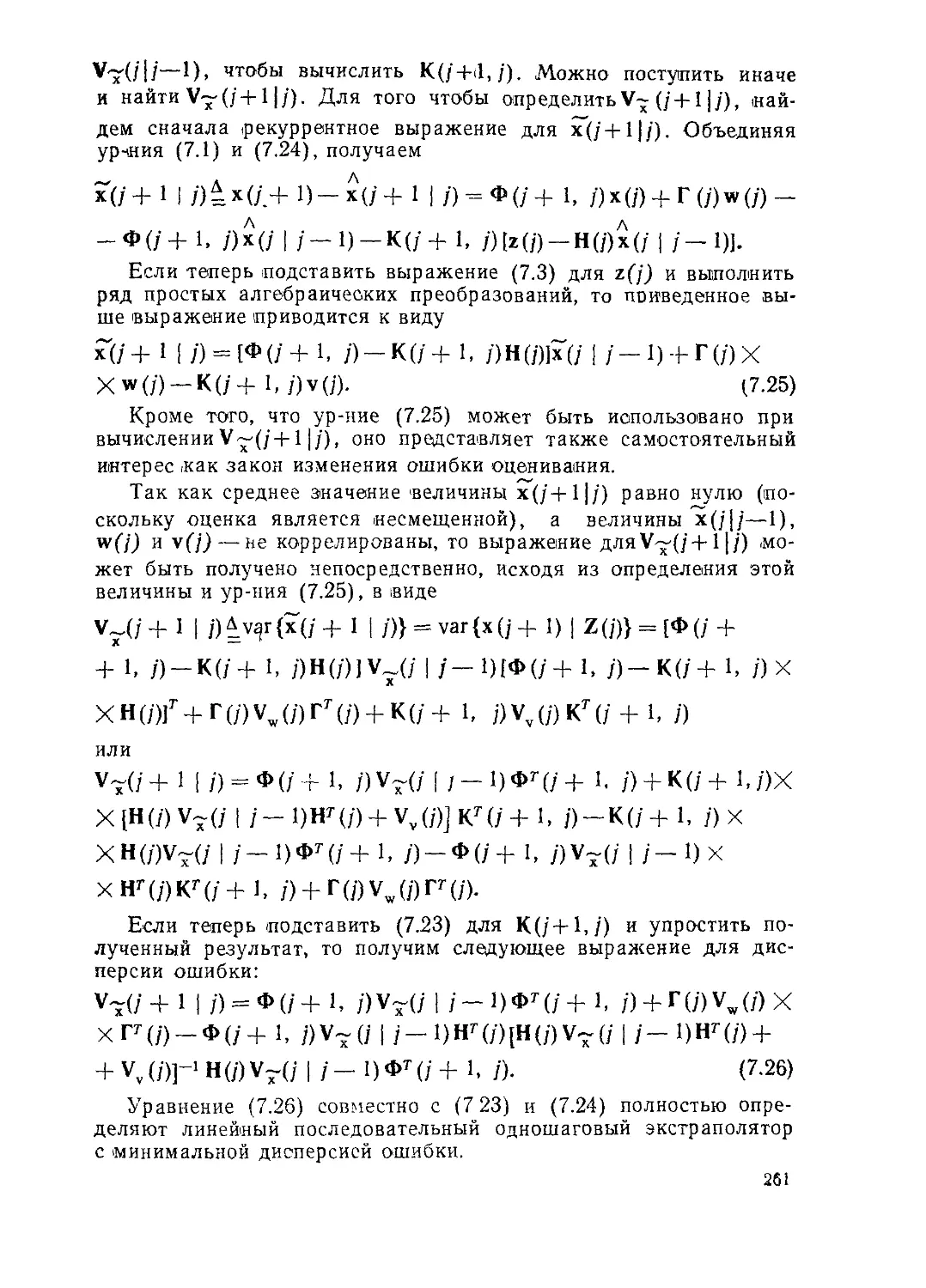

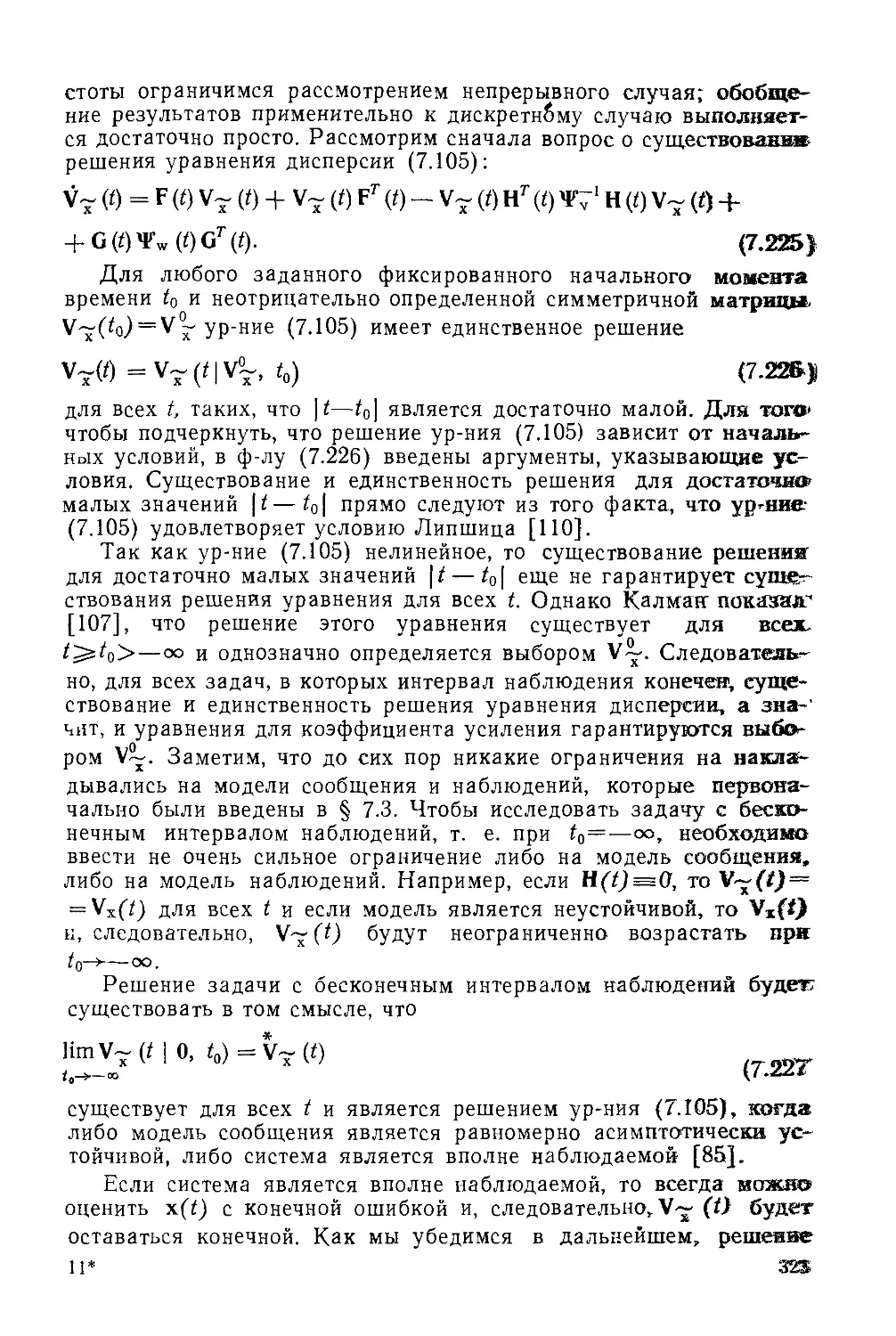

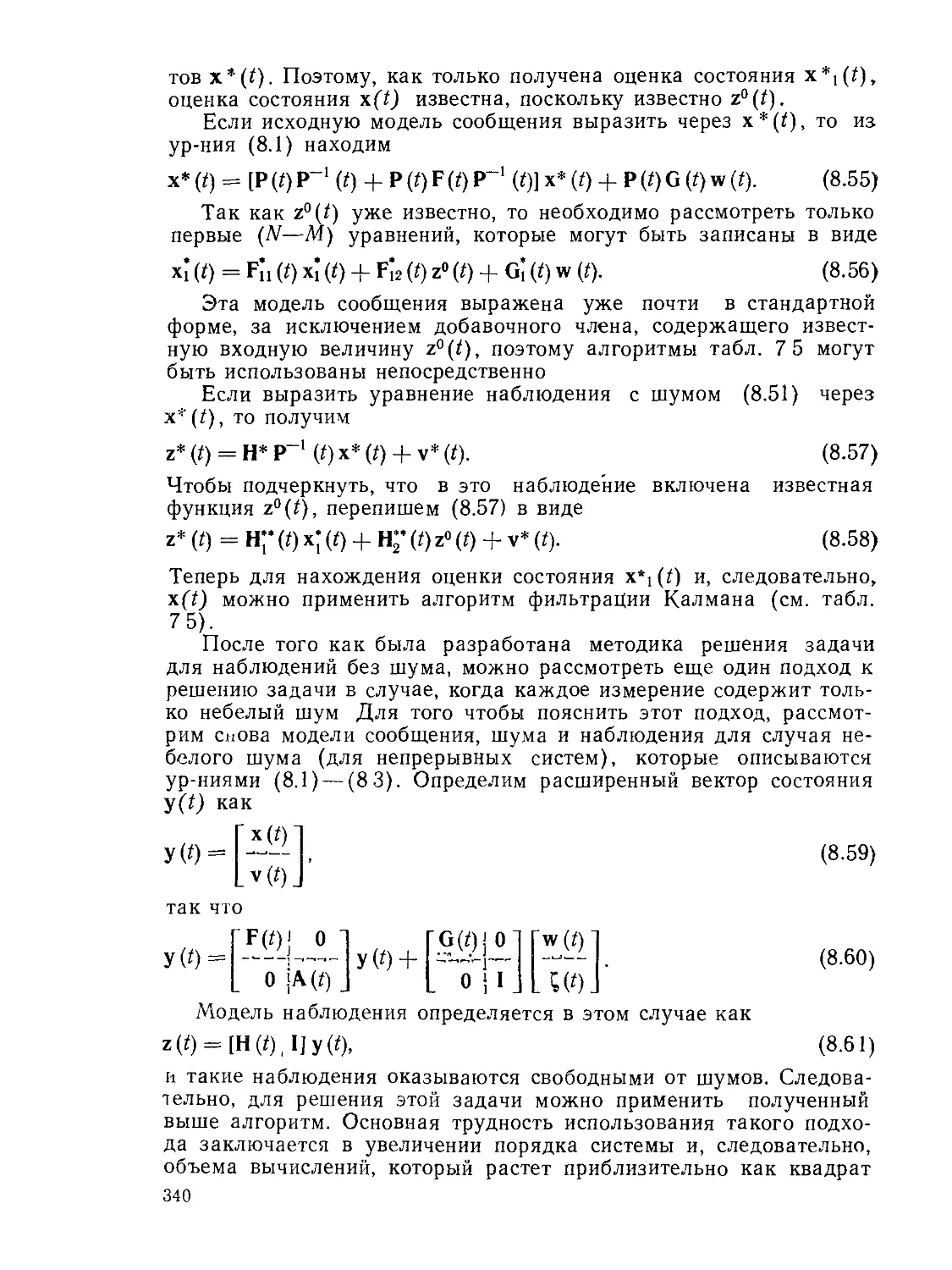

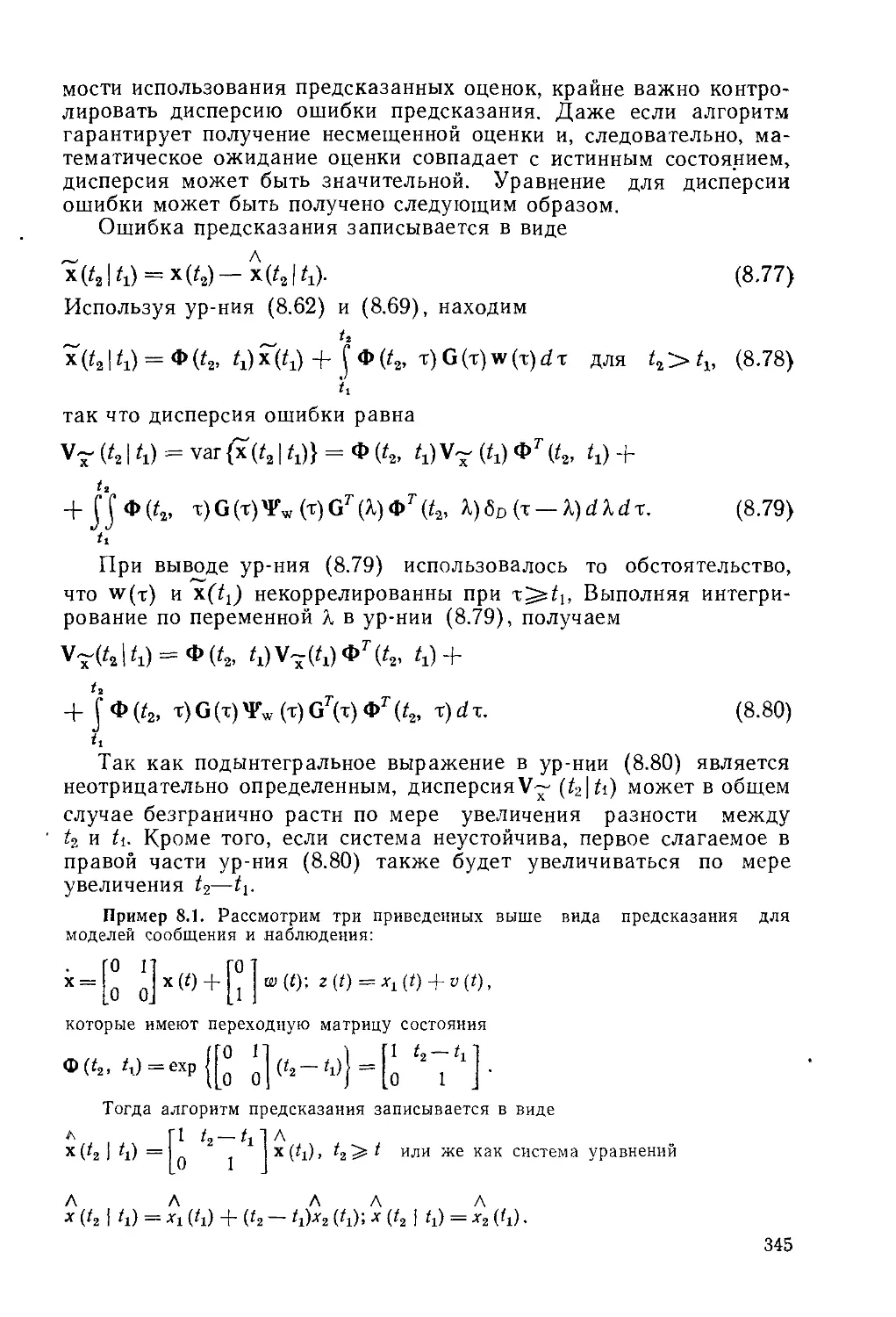

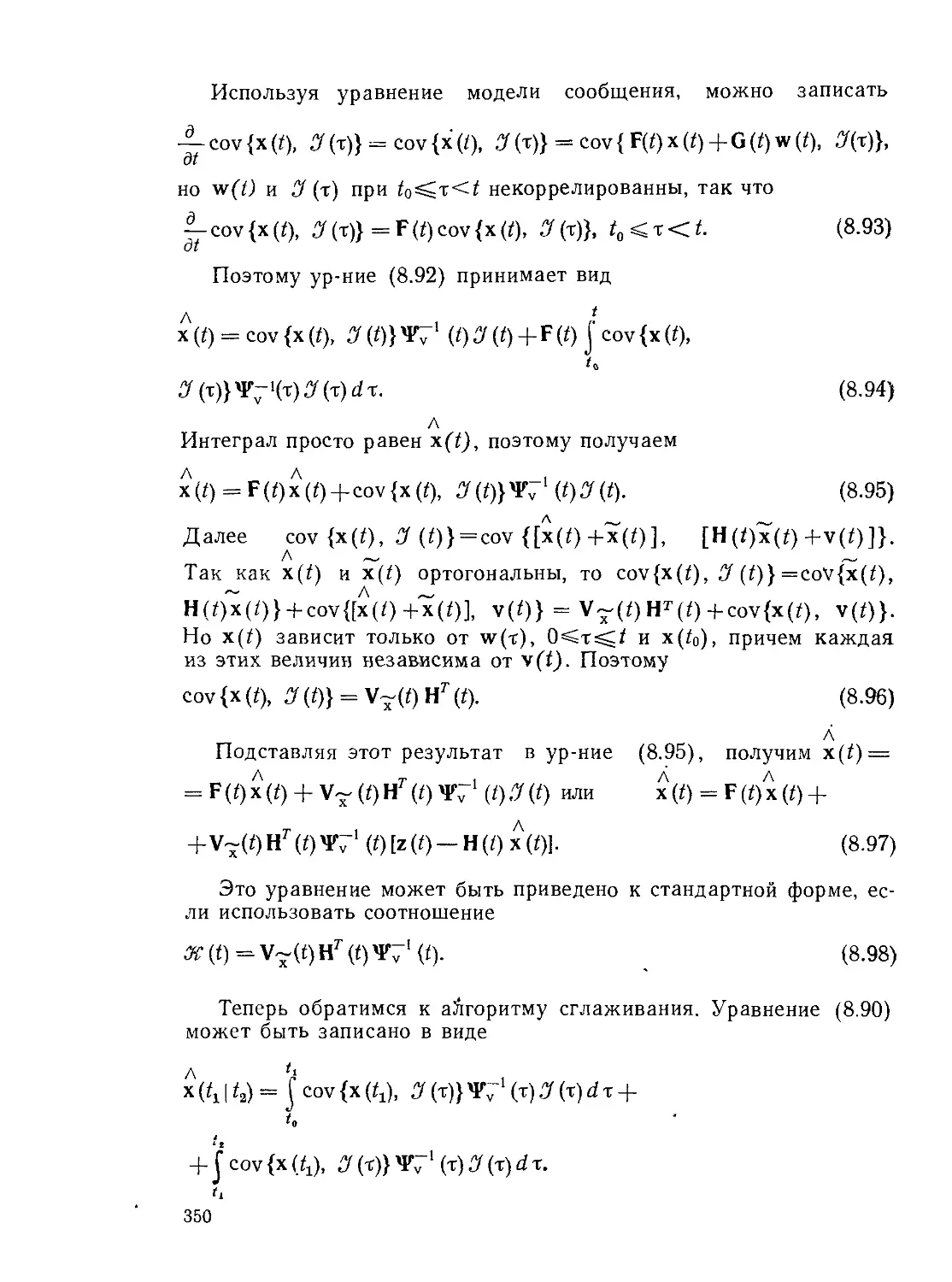

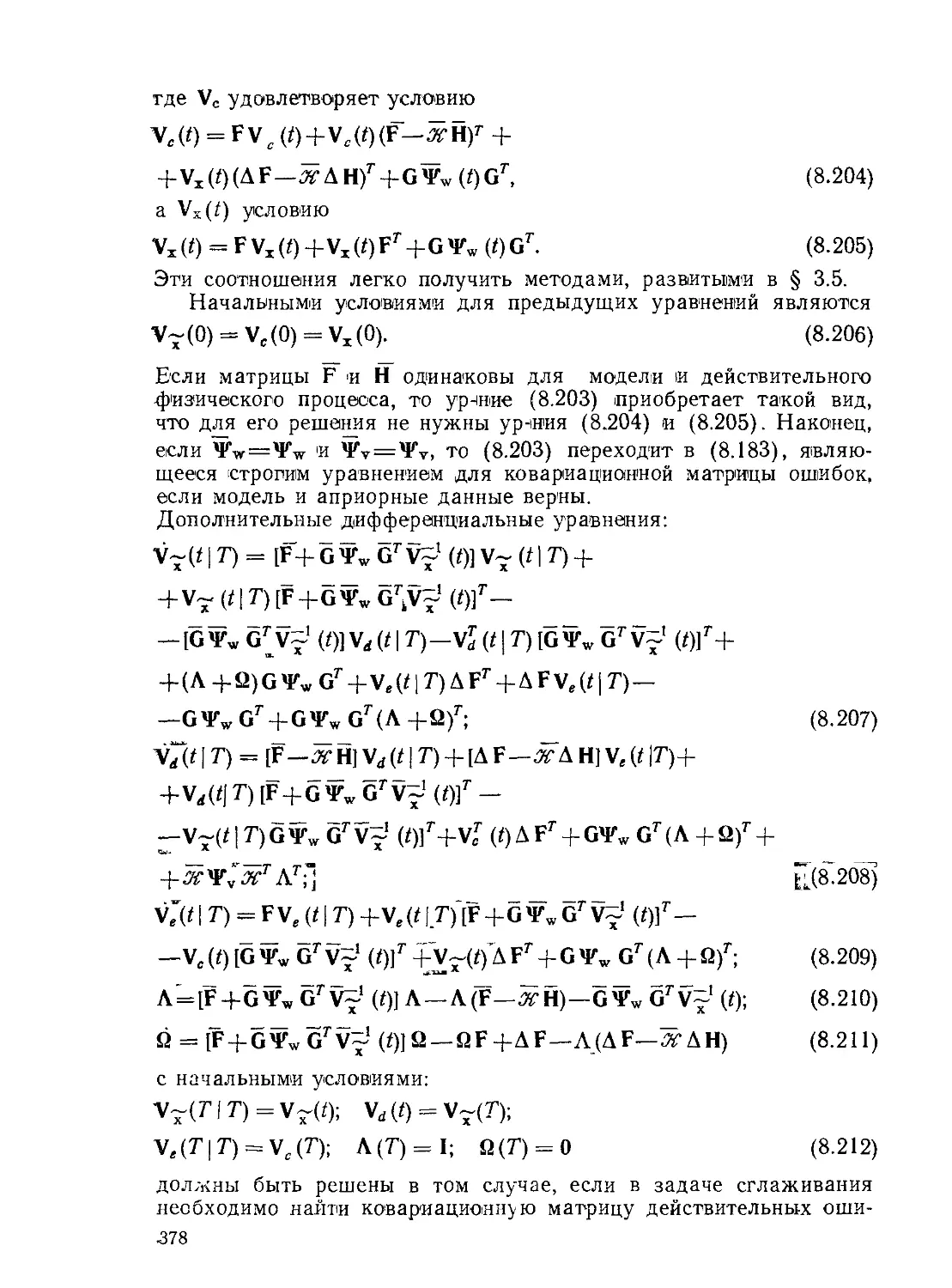

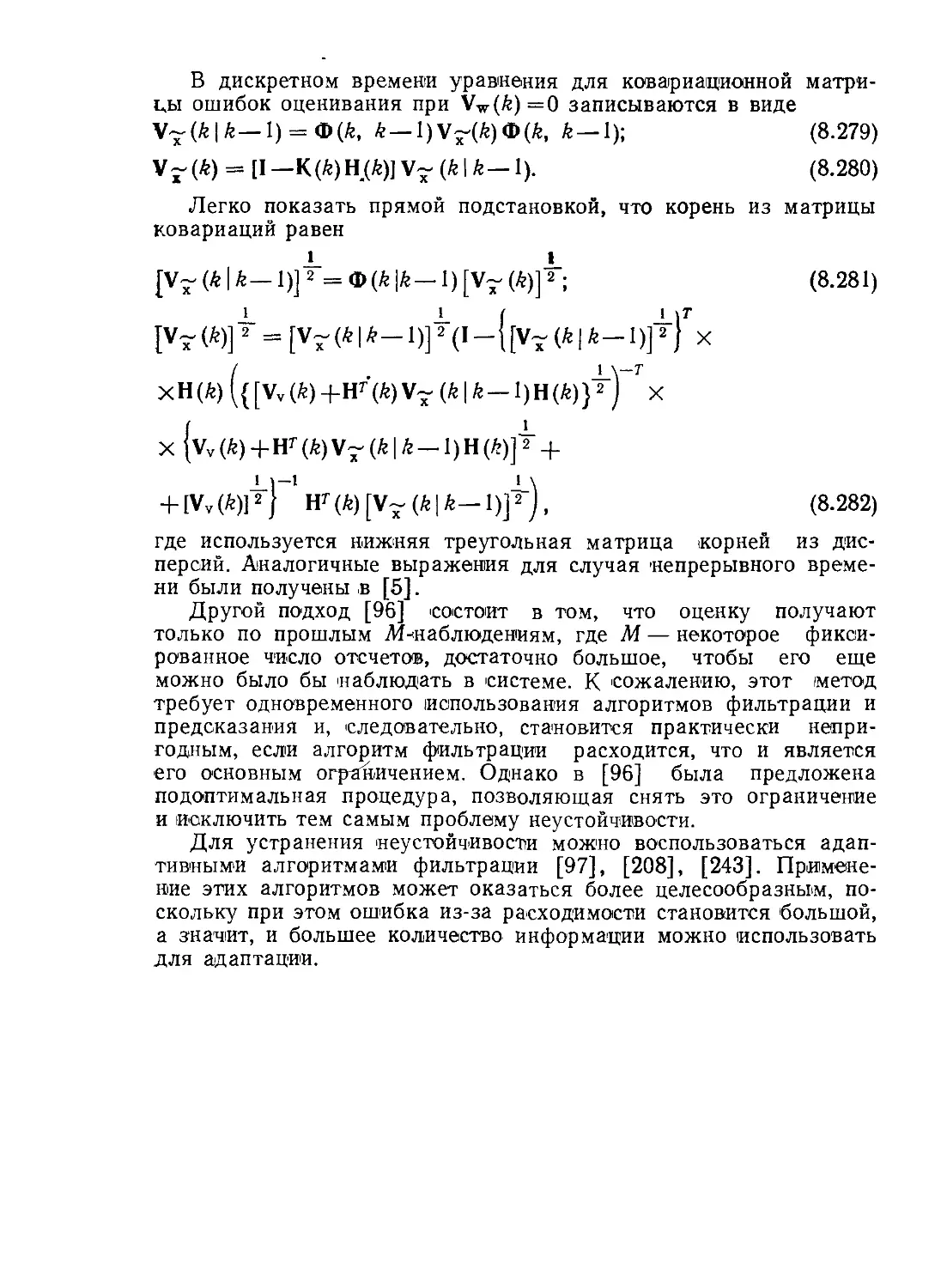

рис. 3.1 представлена графиче-

ская иллюстрация случайного

процесса. Случайный процесс

является функцией двух пере-

менных— времени / и исхода

эксперимента со. Обычно для

представления случайного про-

цесса используется только сим-

вол х(/). Для любого фиксиро-

ванного значения t случайный

процесс является случайной ве-

личиной.

Рассуждения, которые при-

водились в предыдущей главе,

должны быть лишь слегка мо-

Рис. 3 I. Реализации случайного про-

цесса

дифицированы, чтобы их можно было применить для случайных

процессов. Рассмотрим ковариационную, автокорреляционную и

взаимную корреляционную функцию, ортогональные и спектраль-

ные представления случайных процессов, стационарные и эргоди-

ческие случайные процессы и реакцию линейной системы на слу-

чайный процесс. ;

3.2. Вероятностные характеристики

Выражения для вероятностных характеристик случай-

ных процессов в основном такие же, как и для случайных вели-

2—26 33

чин. Для фиксированных t можно определить событие как группу

исходов, для которой случайный JV-мерный вектор х(/) меньше

или равен некоторой постоянной а (а не является функцией вре-

мени) :

А = {<в: х (I, а) < а}. (3.1)

Функция распределения вероятностей х(/) определяется, как

и раньше, следующим образом:

(О («) Д Рх (Л) = Рх [X (/) < «]. (3.2)

Функция плотности вероятности Px(t)(a) и функция распреде-

ления Рх(()(й) связаны между собой соотношениями 1):

.Рх (#) («) =

д а

а

Л (<)(«)= [

— ОО

(3.3)

(3.4)

Результаты § 2.5 могут быть непосредственно распростране-

ны на случайные процессы. Так, ф-лы (2.108) и (2.109) можно

применить к случайным процессам, если быть внимательным при

обозначении временной завиоимости случайных величин. Напри-

мер, если y(J) — функция случайного процесса x(t)

y(O = g[x(O. О»

то

00

£{У(0}(= J g(«. t)pxW(a)da.

— 00

(3-5)

(3.6)

Более детальное исследование средних значений случайных

процессов представлено в следующем параграфе.

3.3. Средние значения

Как было указано в предыдущем разделе, общие мето-

ды исследования средних значений, изложенные в § 2.5, могут

быть непосредственно применены к случайным процессам. Однако

из-за введения временного аргумента некоторые средние случай-

ных процессов не имеют прямого аналога в теории случайных

величин. В частности, отметим связь между понятиями усредне-

ния по времени и по ансамблю и понятиями стационарности и

эргодичности.

О Часто используются другие выражения типа fx(a, t) и px(a, /). (Прим,

авт.).

34

Среднее значение. Вектор математического ожидания

случайного векторного процесса определяется как

Нх(0Д5{х(0}Д У «Рх(0 (я) da.

(3.7)

Если рх(0 не зависит от времени, то говорят, что процесс стацио-

нарный по среднему значениюДостаточным условием незави-

симости Цх(0 от времени является то, что рх(ц(а) не зависит от

времени. Это условие, однако, не необходимо.

Когда случайный процесс стационарен по среднему значению,

среднее по времени этого процесса

х Д lim -Д- С х (/) dt. (3.8)

2tf J

'‘I

Если среднее по времени х стационарного по среднему значе-

нию случайного процесса [см. (3.8)] равно (с вероятностью 1)

постоянному среднему по ансамблю [см. (3.7)], то процесс эрго-

дичен по среднему значению, или просто в среднем.

Вместо оценки вектора средних путем усреднения по непре-

рывному времени можно ввести оценку, полученную усреднением

по дискретному времени. Для эргодического в среднем процесса

вектор среднего по дискретному времени имеет вид

*) Общие вопросы стационарности и эргодичности будут изложены в этой

главе дальше. (Прим авт.).

2> Последовательность случайных величин х* 1, Z=l, 2,... называется сходя-

щейся по вероятности к х, если вероятность того, что случайная величина х*

не достигнет х, равна нулю Аналитически это можно записать как

limPx[||x'—х||>е]=0.

i->to

Более сильной, чем сходимость по вероятности, является сходимость с вероят-

ностью единица. Последовательность случайных величин х1 сходится с вероят-

ностью единица к пределу х, если вероятность, относящаяся к совокупности не-

сходящихся последовательностей реализаций х", равна нулю. Аналитически это

выражается следующим образом: /)ж[Нт||х*—х|| = 0]=1.

Еще более сильной сходимостью является сходимость в среднем. Последова-

тельность случайных величин х* сходится в среднем к пределу х (LIM — предел

в среднем), если

Е {|x!il2}<°° для всех (;

Е{|[х||2} <оо;

limEfllx1—х||2} =0

Важно отметить, что сходимость в среднем не означает сходимости с вероят-

ностью единица.

2*

35

к

•х Л lim ---J----- V, x(feT),

= К_>со 2Я+1 Li

k=-K

(3-9)

где T — интервал квантования во времени. В реальных измере-

ниях невозможно использовать ф-лы (3.7) и (3.8) с бесконечными

пределами. Поэтому усреднение осуществляется по конечному

числу выборок.

С р е д н е кв а д р а ти ч ес к о е значение и дисперсия.

Матрица среднеквадратических значений векторного случайного

процесса имеет вид

00

Фх(О Д Е{х(0 хг (/)} = Ja ат рх{Г) (a) da.

— 00

(3.10)

Это выражение в точности соответствует (2.116). Если средне-

квадратическое значение не является функцией времени, должно

быть выполнено другое необходимое условие стационарности

случайного процесса. Если процесс и стационарен и эргодичен,

то среднеквадратическое значение, вычисленное путем усреднения

по ансамблю реализаций, равно (с вероятностью 1) среднему по

времени от произведения ххт:

_____ i Ь

Фх = хх7'ДНт------ I x(f)xr(t)dt. (З.И)

Нетрудно записать дискретный аналог ф-лы (3.11). Матрица

среднеквадратических значений эргодического процесса, получен-

ная усреднением по дискретному времени, равна

к

^=lim У] х(6Т)хг(£Т). (3.12)

Л—>00 Z Д -ф" *

k=-K

Матрица дисперсий векторного случайного процесса имеет вид

Vx (t) Д var {х (0) = Е {[х (0 — рх (0] [х (0 — рх (0]г } =

₽ Jl« ——Рх(01гРх(о(«И«- (3.13)

—со

Отсюда непосредственно следует, что

Ух(0 = Фх(0-рх(0^(0. (3.14)

Будем опускать индекс х в обозначении матрицы дисперсий V

в тех случаях, когда это не вызовет путаницы.

36

Корреляционные и ковариационные функции.

Рассмотрим матрицу средних произведения двух значений вектор-

ного случайного процесса с временным сдвигом

Фх(*1. Х2)ДЕ{х(Х1)хг(Х2)}, (3.15)

которую называют матрицей автокорреляционных функций. Ис-

пользуя результаты § 2.5, нетрудно получить следующее выраже-

ние для Фх (Xi, л2):

Фх(Хр Л.2)=Л«₽грх(М)> Х(х2)(«, $)dad$. (3.16)

— <30

Введем также матрицу взаимных корреляционных функций

двух векторных случайных процессов:

Фху(/, т)Л Е{х(ПуЧт)}. (3.17)

Подобным же образом вводятся матрицы ковариационных и

взаимных ковариационных функций. Матрица 'ковариационных

функций (называемая также ядром ковариации) определяется

следующим образом:

Vx (t, т) = cov {х (/), X (т)} Д Е {[х (t) - рх (/)] [х (т) - (т)Г }, (3.18)

т. е. представляет собой среднее произведения центрированных

случайных процессов в моменты времени t и т. Ясно, что

Vx (0 = var {х (/)} = cov (х (0, х (/)} = Vxx (/, /). (3.19)

Матрица взаимных ковариационных функций равна

Vxy (t, т) = cov {х (/), у (т)} =

== £{[х (?) — рх (01 [у (т) - ру (т)Г }. (3.20)

Легко показать, что матрицы средних дисперсий и ковариацион-

ных функций связаны соотношением

Vx(/, т) = фх(/, т)-рх(0рхЧт), (3.21)

а матрицы соответствующих смешанных моментов •— соотноше-

нием

vxy (t, т) = Фху (/, т) - рх (0 р£ (т). (3.22)

Важность первых двух статистических моментов, которые опре-

деляют среднее значение, среднеквадратическое значение, диспер-

сию, корреляционную и ковариационную функции случайного

процесса, обусловлена двумя факторами. Во-первых, обычно на-

много легче найти среднее значение или ковариационную функ-

цию случайного процесса, чем закон распределения. Во-вторых,

многие важные фундаментальные задачи, связанные со случайны-

ми процессами, могут быть решены на основе знания вектора

среднеквадратического значения и матрицы ковариационных

функций. В частности, задачи «линейной оценки» могут быть

37

легко решены, если основываться на знании этих вероятностных

характеристик.

Однако важно не переоценить надежды, возлагаемые на ис-

пользование векторов средних и матрицы ковариационных функ-

ций Можно показать, например, что для определения ошибок

при оценивании диопераии случайного сигнала по его реализации

конечной длительности потребуется четвертый момент распреде-

ления. Таким образом, с помощью только первых двух моментов

можно решить хотя и большое число задач, но не все.

Стационарность и эргодичность Случайные про-

цессы делятся на два широких класса—стационарные и неста-

ционарные (называемые также эволюционными). Стационарным

называется процесс, в котором совместное распределение или

плотность вероятности инвариантны во времени. Случайный про-

цесс является строго стационарным k-vo порядка, если совместное

распределение или плотность k-ro порядка не зависят от времен-

ного сдвига, так что

Px(f,), . x(tk) («, Р...х) =

= Px(f,+T)), x(/.+T)), , «Й-И) («> ₽.х) Для любого Т). (3.23)

Процесс является строго стационарным, если он строго стациона-

рен k-ro порядка при любом k

Можно указать поистине фантастическое число работ по опре-

делению стационарности в строгом смысле Поэтому нас обычно

будет удовлетворять определение стационарности в широком

смысле, для которой требуется независимость от выбора начала

отсчета времени только первых двух моментов. Если процесс

строго стационарный второго порядка, он стационарен в широком

смысле, обратное не справедливо Для стационарности в широ-

ком смысле требуется, чтобы вектор среднего значения не зави-

сел от времени, так что

ОО

Рх (0 = Е {х (0} = J « Рх(0 («) d а = рх, (3.24)

—со

и чтобы матрица корреляционных функций была функцией только

временного сдвига:

Фх(^, т) = £{х(0х^(т)} =

со

= Ja^pxp), х(т)(«, $)dad$ = Сх(/ — т). (3.25)

— 00

Матрица корреляционных функций стационарного в широком

смысле процесса может быть записана в виде

Фх(^ + т) = Сх(т). (3.26)

Более слабым, чем стационарность в широком смысле, но все

же очень полезным для дальнейшего изложения является поня-

тие ковариационной стационарности. Случайный процесс является

38

ковариационно стационарным, если матрица ковариационных

функций зависит только от временного сдвига t—т, так что

V,(Z, T) = Rx(f-T)

или

VXU / + t) = Rx(t).

(3.27)

(3.28)

Можно легко связать понятия стационарности в широком

смысле и ковариационной стационарности. Так как

Vx (t, т) = Фх(/, т) - рх(0у* (т), (3.29)

то для ковариационно стационарного случайного процесса из

ф-лы (3 27) находим

Фх(/, t) = Rx(^-t) + px(0^(t)=Cx(^-t). (3.30)

Таким образом, 'случайный процесс стационарен в широком

смысле (или является стационарным второго порядка), если он

ковариационно стационарен и если он стационарен в среднем.

При этом px(t) в (3.30) можно заменить на цх-

Как отмечалось выше, в некоторых случаях усреднение по

ансамблю можно заменить усреднением по времени. Строго

стационарный процесс x(f) является эргодическим, если для лю-

бой функции f[x(0] средние от этой функции по времени на ко-

нечном интервале времени или по выборке конечного размера

сходятся (с вероятностью 1) к среднему по ансамблю [56].

Таким образом, для эргодического процесса при произволь-

ной f [х]

к

,im ттгУf [х^г)] = £{f

К—>с° Л 1

k=Q

с вероятностью 1.

(3.31)

1 н

hm — \ f [х (ЭД dt = Е {f [х (0]}

t f->00 J

' о

Случайный процесс называется эргодическим в среднем, если

средние по времени на конечном интервале и по выборке конеч-

ного размера

t, _ к

= х(КП = ^7?2хт (3’32)

1 О k=0

сходятся к константе при увеличении длины реализации. Другими

словами, если

[ IjrnjV—(ЭД = 0; lim V-(ДТ) = 0,

11—>оо

(3.33)

s»

так что средние от реализации конечной длительности стремятся

к средним по ансамблю, то процесс эргодичен в среднем. Можно

показать [182], что необходимым и достаточным условием эрго-

дичности в среднем является_сходимость к нулю ковариации слу-

чайных величин х (КТ) [или х (£/)] и х (t):

Vx 7 (t, КТ) = cov {X (О, X (КТ)} (3.34)

при ДТ=^->оо, т. е.

lim V-(/, ДТ) = 0.

KT=t-+<° * х

(3.35)

Необходимым условием эргодичности является строгая ста-

ционарность. Таким образом, все эргодические процессы стацио-

нарны, но не все стационарные процессы эргодические.

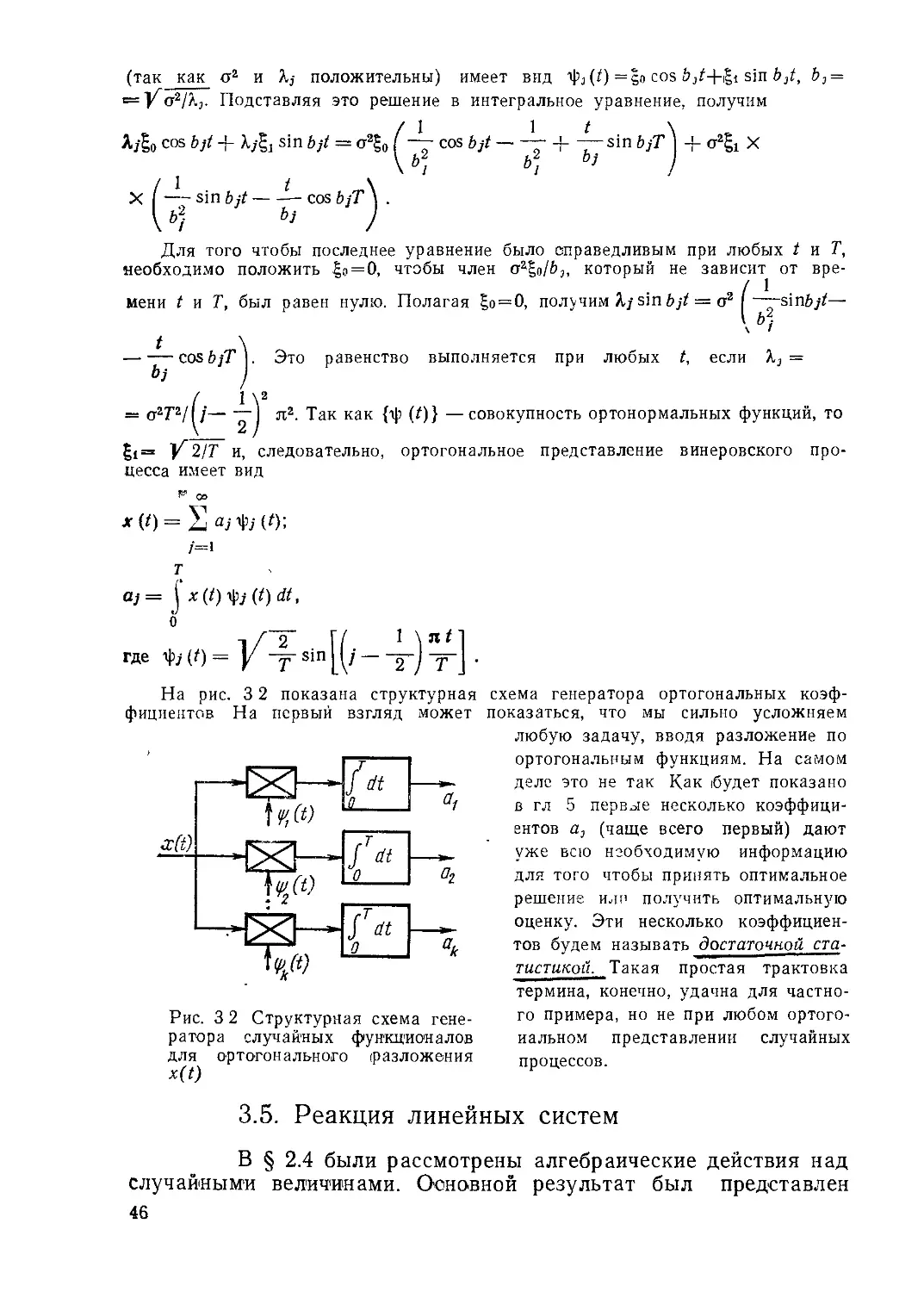

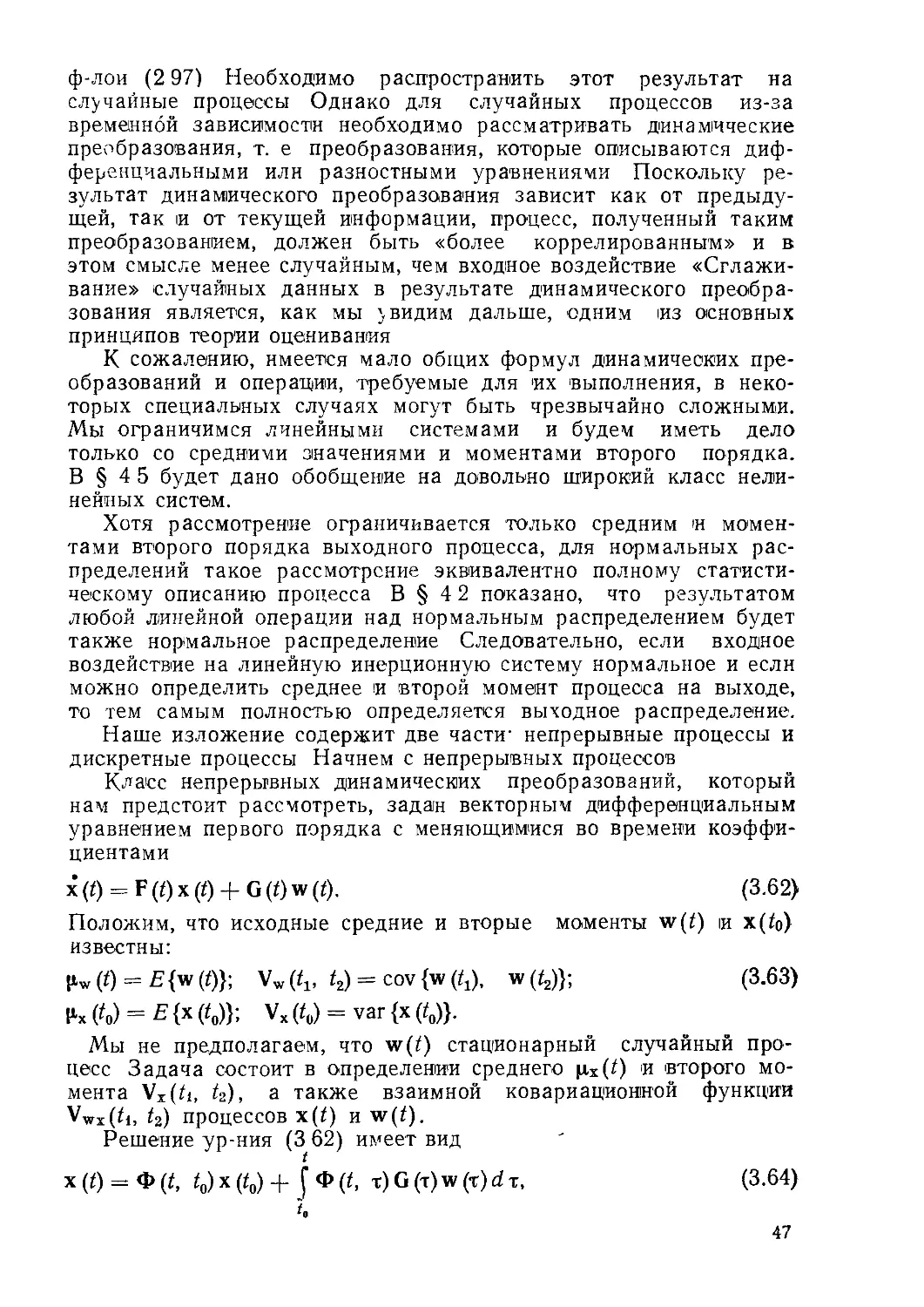

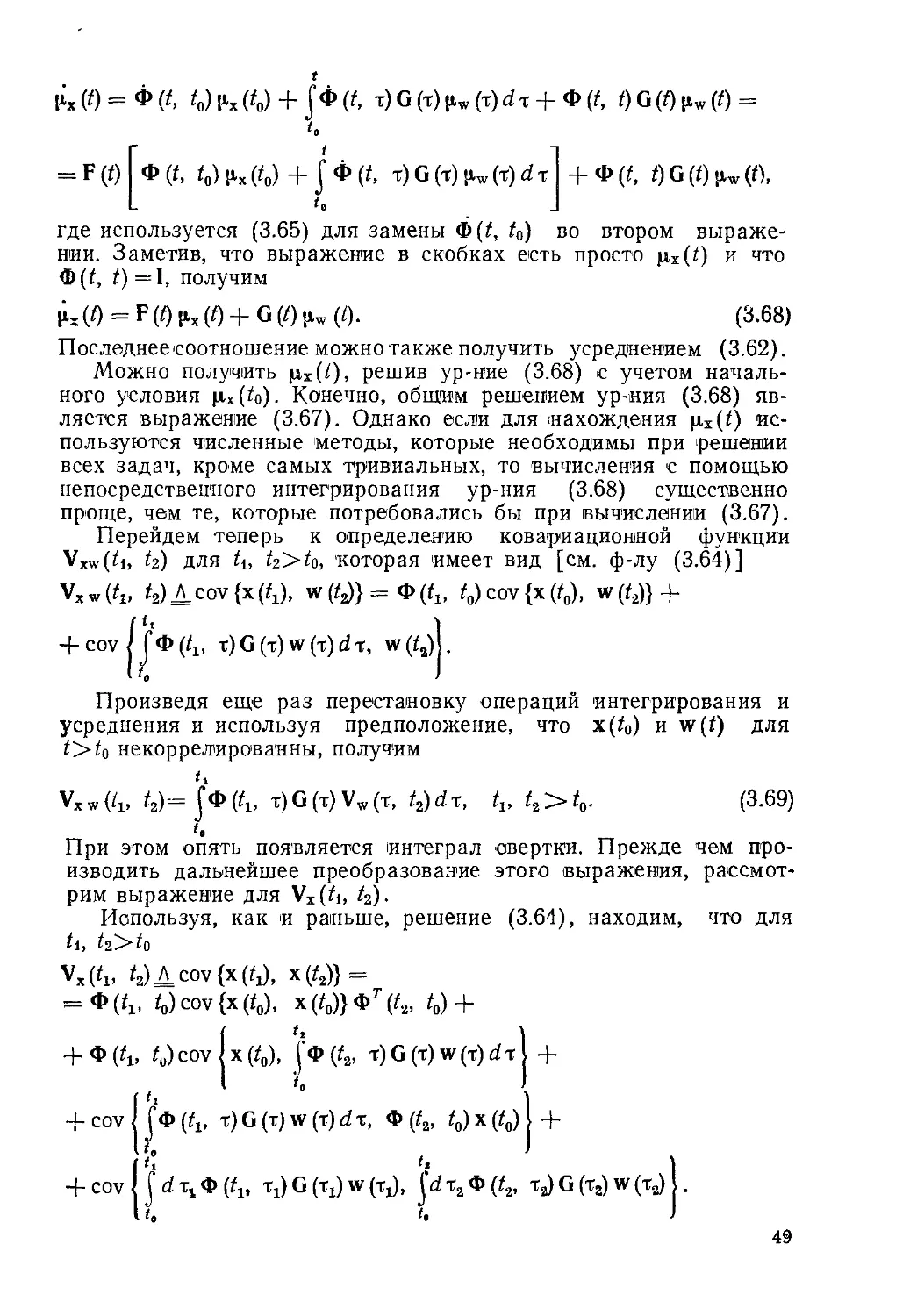

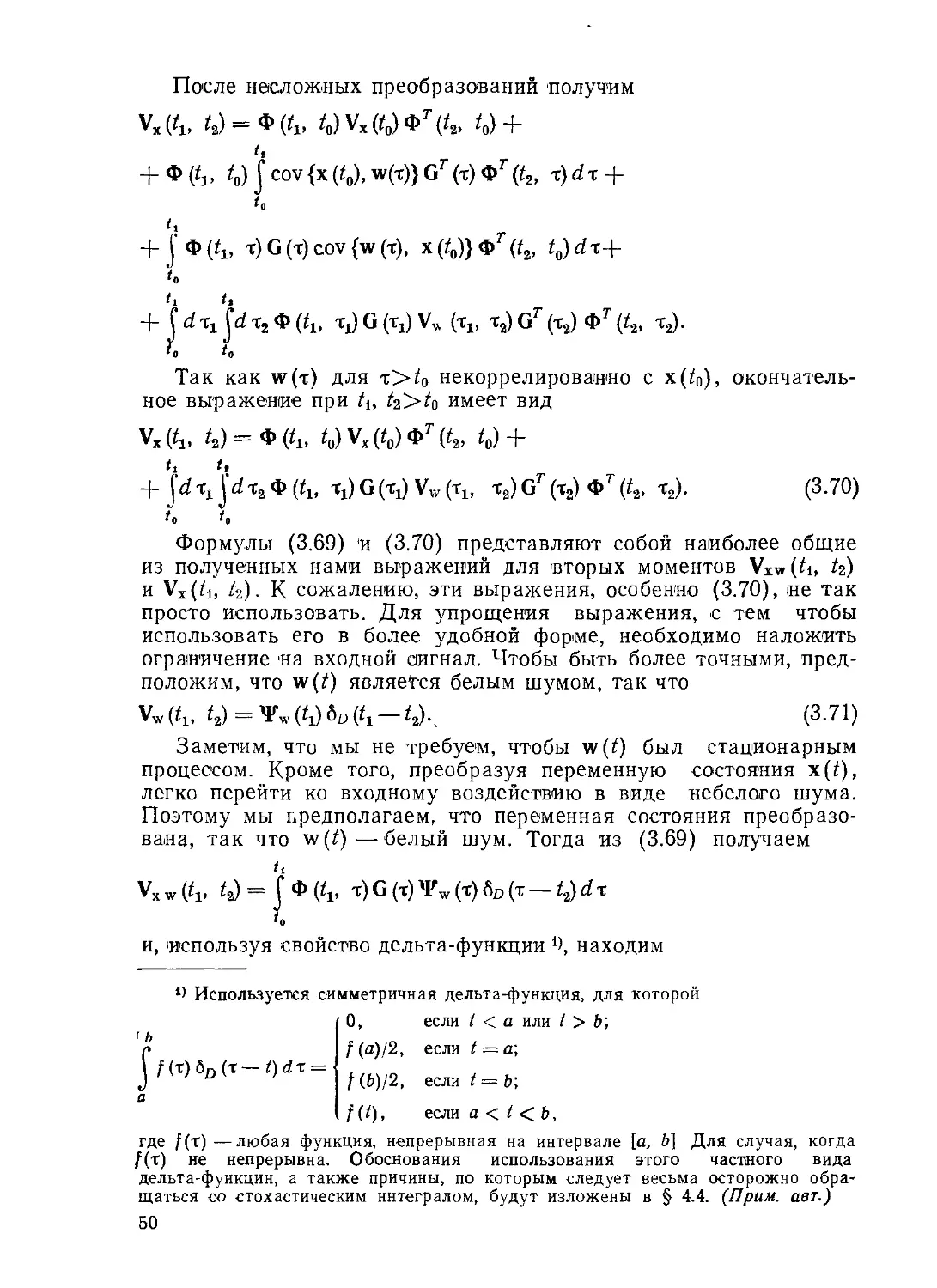

3.4. Спектральные и ортогональные

представления

В этом разделе будут рассмотрены два метода характе-

ризации случайных процессов, которые связаны с разложением

сигнала на простые элементарные составляющие.

Спектральное представление. Средняя мощность

i-й реализации случайного скалярного эргодического процесса

хг (i) D

Т/2

PaV = lim — f[xf(t)]2dt. (3.36)

т->® Т J

—Т/2

Для того чтобы ввести преобразование Фурье сигнала x*’(f),

который может иметь бесконечную энергию, рассмотрим сначала

усеченный сигнал с нулевым средним

х£ (0 — р,ж

О

x‘T(t)= {

М>Т/2.

(3.37)

Преобразование Фурье усеченного сигнала имеет вид

оо Т/2

XlT (s) = J Ху (0 e~s< dt = J [х‘ (t) — е~s z dt.

— оо —T/2

(3.38)

о Обозначение х*(() используется как сокращенная запись х (i, <ог). (Прим,

авт.).

49

Средняя мощность усеченного сигнала или исходного сигнала

на интервале от —TJ2 до Т/2 в соответствии с теоремой Парсе-

г.аля

со i со

(0/2(0^=^ J (3.39)

—СО — 1 во

равна

1 С Г I /Л12 Г [ ХТ W]2 .. 1 f ХТ Is) ХТ s) J /Ч ДСП

Y J dt= J—-—^=—— j --------------------------ds. (3.40)

—Т)2 —со — ioo

Назовем величину XlT (s)XlT (—s)/T спектральной плотностью

мощности i-й реализации x{(t) на интервале времени —Г/2^

^7^Т/2 и обозначим ее через Rlx (Т, s). Определим спектраль-

ную плотность случайного сигнала x(t) как предел (при Г—>-<х>)

среднего по ансамблю спектральной плотности мощности реали-

зации

/?_(&) = lim — Е(Х (s)X (— s)l = limE{flx(T, s)}, (3.41)

Г—>с» Т 1 ’ Т-><х

где

Rx (Т- s) A (s) Хт (- s)/T. (3.42)

Для того чтобы этот результат был справедлив, мы должны

ввести ограничение, состоящее в том, что Xt(s)—сходящаяся

несмещенная оценка X(s) в том смысле, что

lim E[RX(T, $)} = Rx(s) и limvar {RX(T, s)] = 0.

r "tf? ,

Для выяснения условий, при которых выполняется первое тре-

бование, рассмотрим выражение

г Г/2

ч)=£!4 И

—T/2

Ц JJr, - у е- = " е' Si X, d Ч.

—7/2

(3.43)

которое заменой переменных т=А,1—Ла, t]=Xi+X2 приводится к

виду

т

Е{/?Х(Г, S)}= J[l-M)/4(T)e-STdt =

—т

т т

= j>x(r)e-sx dx - у^Дж(т)е-5Х^т.

—Г —т

(3.44)

41

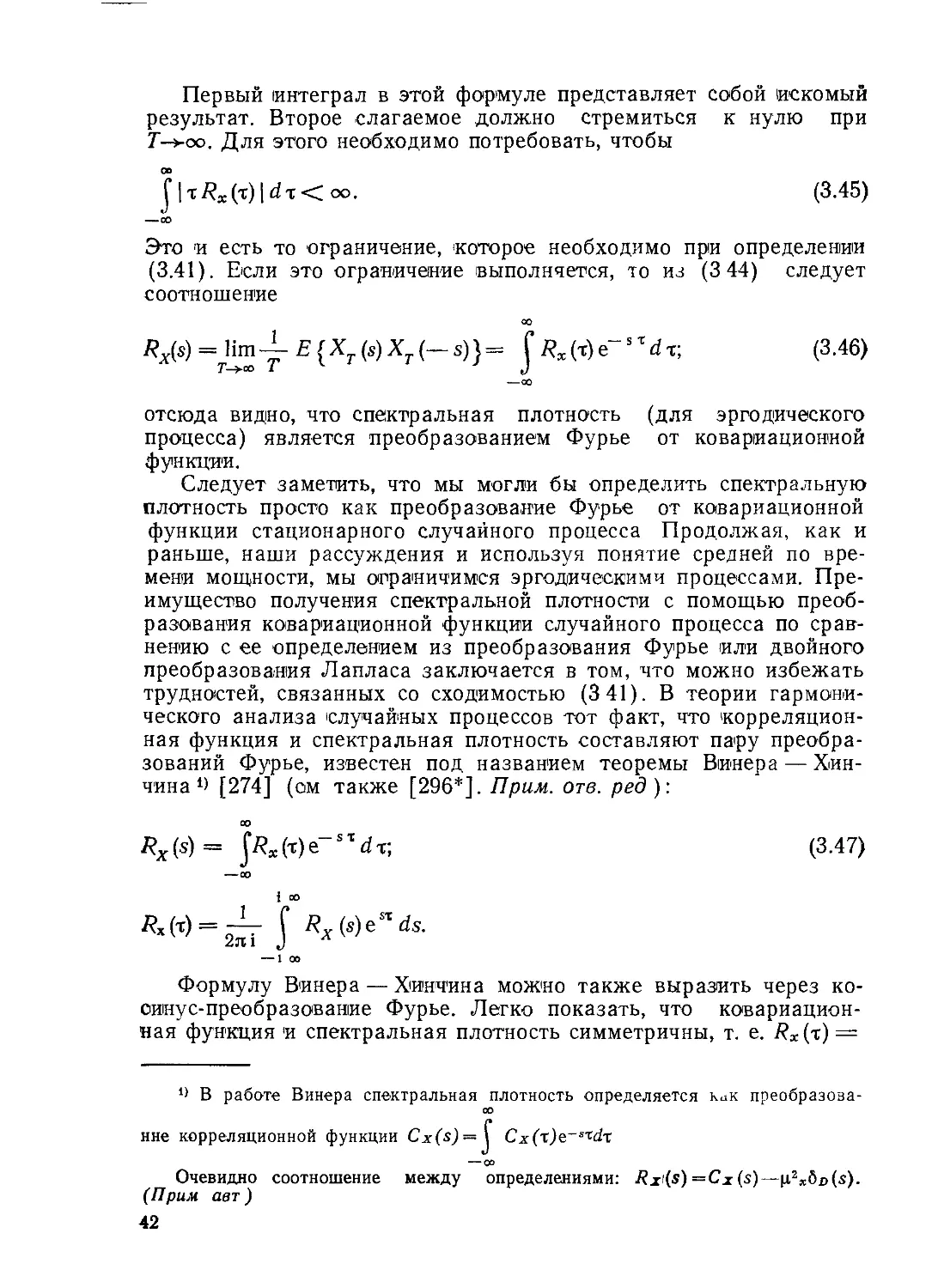

Первый интеграл в этой формуле представляет собой искомый

результат. Второе слагаемое должно стремиться к нулю при

Т—>оо. Для этого необходимо потребовать, чтобы

J |тДх(т) | dr <2 оо. (3.45)

—оо

Это и есть то ограничение, 'которое необходимо при определении

(3.41). Если это ограничение выполняется, то из (3 44) следует

соотношение

оо

ед = 1 im4- Е (хт (S) XT(-S)}= Г Rx (т) е"s т d т; (3.46)

Т—>оо I J

—оо

отсюда видно, что спектральная плотность (для эргодического

процесса) является преобразованием Фурье от ковариационной

функции.

Следует заметить, что мы могли бы определить спектральную

плотность просто как преобразование Фурье от ковариационной

функции стационарного случайного процесса Продолжая, как и

раньше, наши рассуждения и используя понятие средней по вре-

мени мощности, мы ограничимся эргодическими процессами. Пре-

имущество получения спектральной плотности с помощью преоб-

разования ковариационной функции случайного процесса по сравг-

нению с ее определением из преобразования Фурье или двойного

преобразования Лапласа заключается в том, что можно избежать

трудностей, связанных со сходимостью (3 41). В теории гармони-

ческого анализа случайных процессов тот факт, что корреляцион-

ная функция и спектральная плотность составляют пару преобра-

зований Фурье, известен под названием теоремы Винера — Хин-

чина [274] (ом также [296*]. Прим. отв. ред):

оо

flx(s)= ^Rx(-t)e-sxdv, (3.47)

—оо

i оо

— 1 оо

Формулу Винера — Хинчина можно также выразить через ко-

синус-преобразование Фурье. Легко показать, что ковариацион-

ная функция и спектральная плотность симметричны, т. е. Rx(t) —

*> В работе Винера спектральная плотность определяется как преобразова-

оо

ине корреляционной функции Cx(s) = J Cx(t)e~sTdx

— со

Очевидно соотношение между определениями: Rx(s)=Cx(s)—|12x6d(s).

(Прим авт )

42

==Rx(—т) и Rx(s) =iRx(—$)• Используя формулу Эйлера, полу-

чим из (3.47) (где s = ko):

Rx(s) = J Rx (т) cos co т d x = 2 J Rx (?) cos co т d t; (3.48)

—оо 0

Rk(t) — jRx(a>) coscor d co = — Jrx(co) coscoxdco. (3.49)

— 00 0

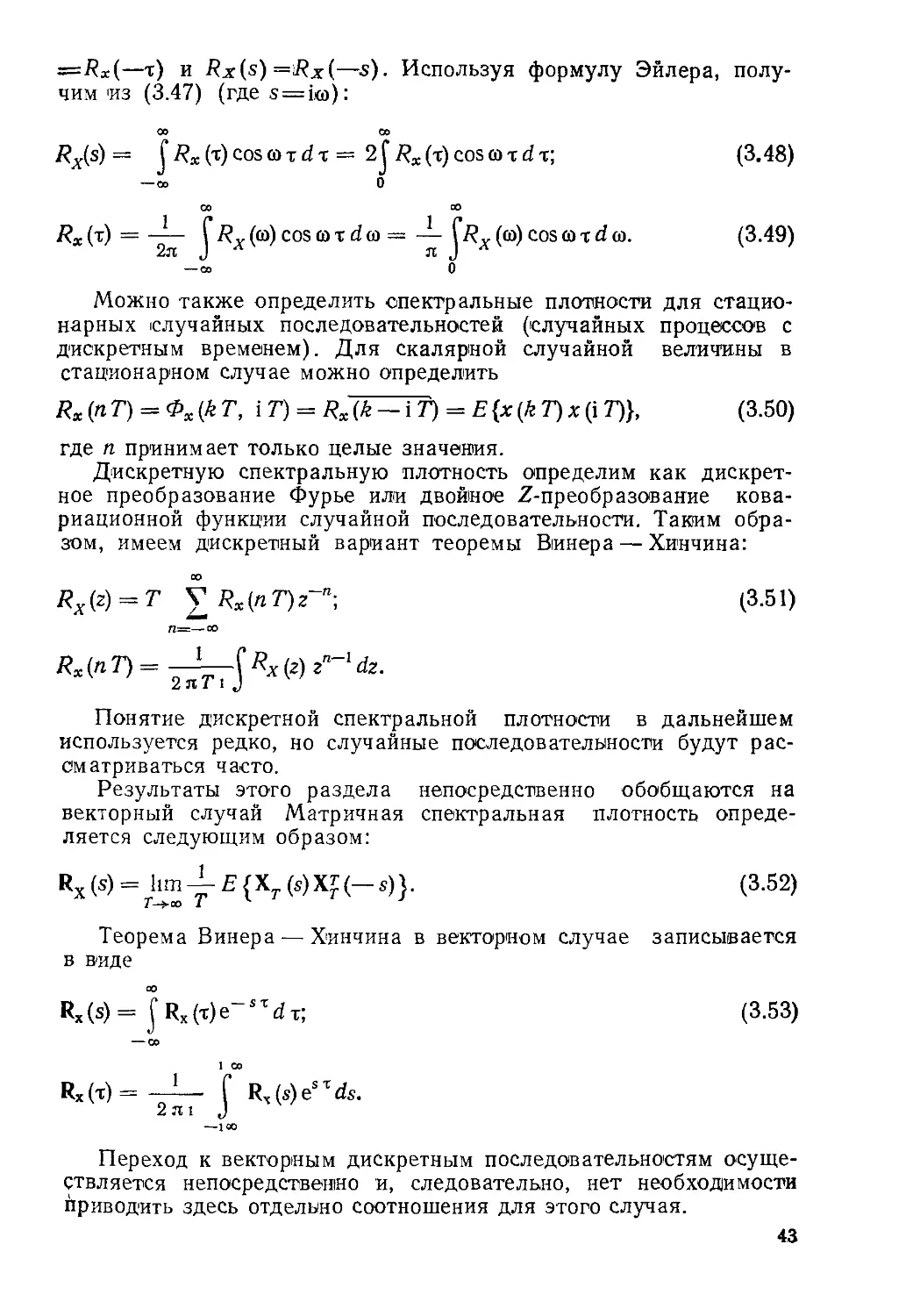

Можно также определить спектральные плотности для стацио-

нарных случайных последовательностей (случайных процессов с

дискретным временем). Для скалярной случайной величины в

стационарном случае можно определить

Rx (пТ)— Фх(кТ, IT") = Rx(k~iT) = E{x(kT)x (i Т)}, (3.50)

где п принимает только целые значения.

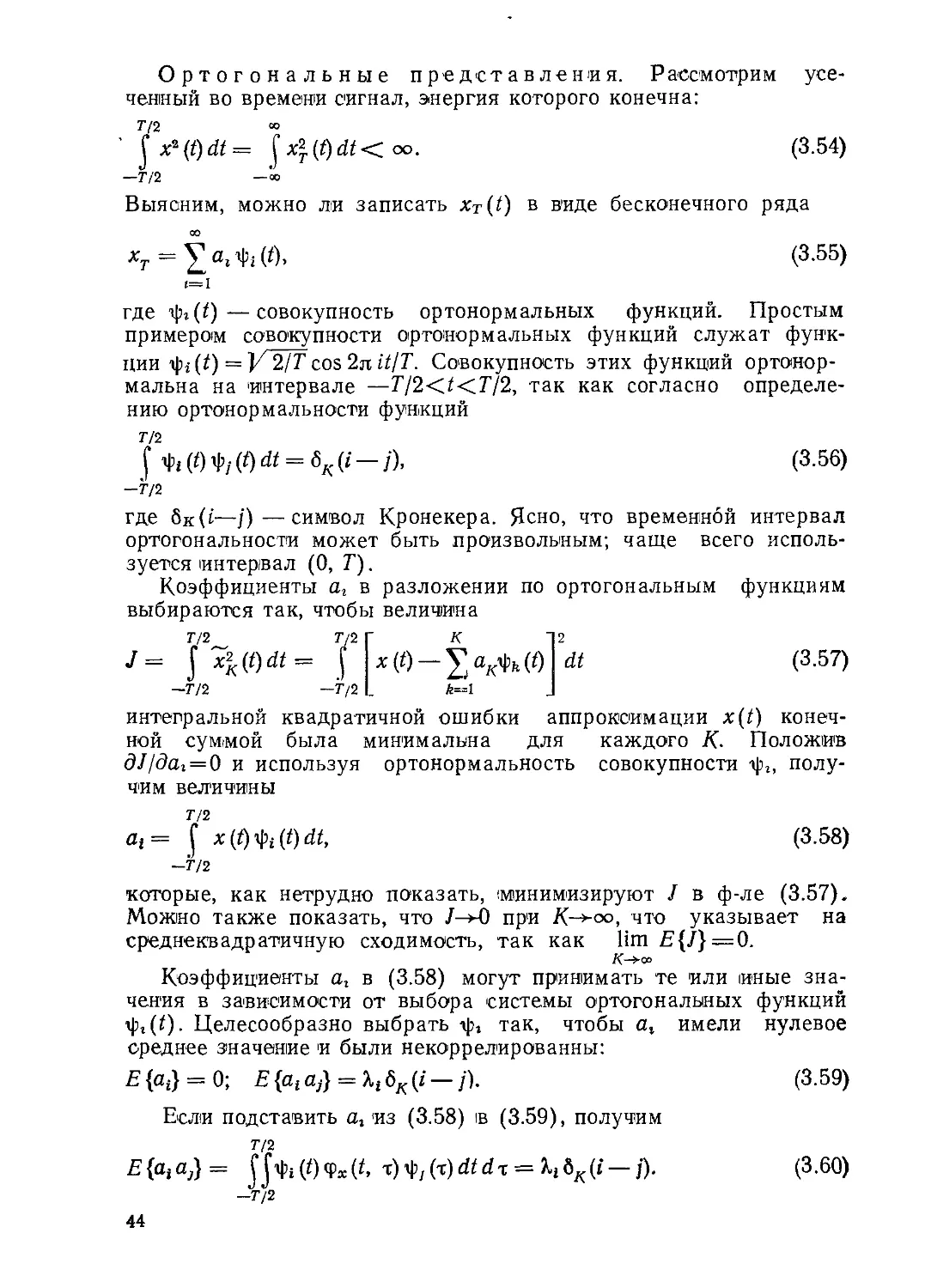

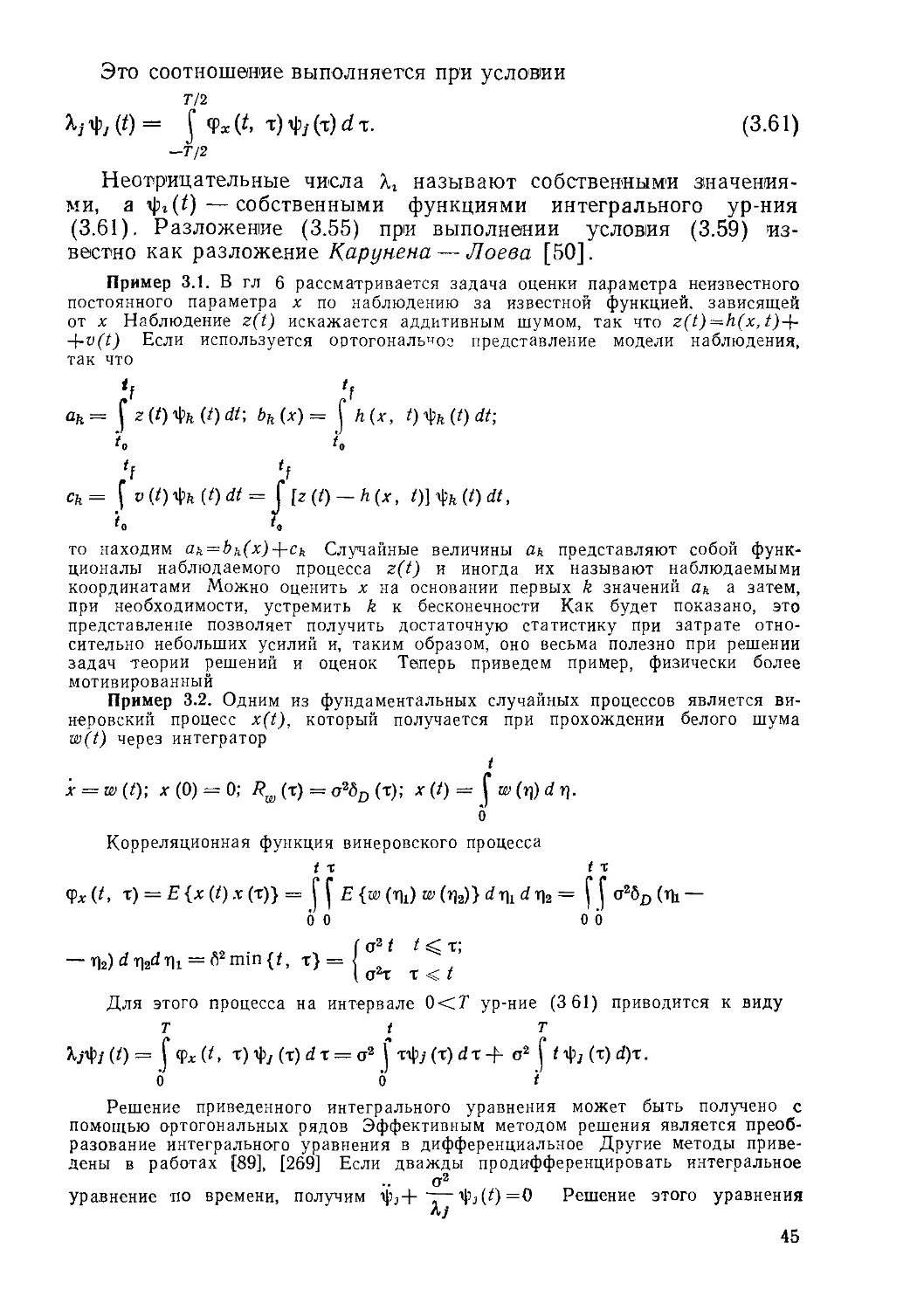

Дискретную спектральную плотность определим как дискрет-